Red Hat Training

A Red Hat training course is available for RHEL 8

システムデザインガイド

RHEL 8 システムの設計

概要

多様性を受け入れるオープンソースの強化

Red Hat では、コード、ドキュメント、Web プロパティーにおける配慮に欠ける用語の置き換えに取り組んでいます。まずは、マスター (master)、スレーブ (slave)、ブラックリスト (blacklist)、ホワイトリスト (whitelist) の 4 つの用語の置き換えから始めます。この取り組みは膨大な作業を要するため、今後の複数のリリースで段階的に用語の置き換えを実施して参ります。詳細は、Red Hat CTO である Chris Wright のメッセージ を参照してください。

Red Hat ドキュメントへのフィードバック (英語のみ)

Red Hat ドキュメントに関するご意見やご感想をお寄せください。また、改善点があればお知らせください。

特定の文章に関するコメントの送信

- Multi-page HTML 形式でドキュメントを表示し、ページが完全にロードされてから右上隅に Feedback ボタンが表示されていることを確認します。

- カーソルを使用して、コメントを追加するテキスト部分を強調表示します。

- 強調表示されたテキストの近くに表示される Add Feedback ボタンをクリックします。

- フィードバックを追加し、Submit をクリックします。

Bugzilla からのフィードバック送信 (アカウントが必要)

- Bugzilla の Web サイトにログインします。

- Version メニューから正しいバージョンを選択します。

- Summary フィールドにわかりやすいタイトルを入力します。

- Description フィールドに、ドキュメントの改善に関するご意見を記入してください。ドキュメントの該当部分へのリンクも追加してください。

- Submit Bug をクリックします。

パート I. インストールの設計

第1章 サポート対象の RHEL アーキテクチャーおよびシステム要件

Red Hat Enterprise Linux 8 は、ワークロードの提供にかかる時間や労力の軽減に必要なツールを使用することで、ハイブリッドクラウドデプロイメント全体に安定性、安全性、一貫性のある基盤を提供します。RHEL は、対応しているハイパーバイザー環境やクラウドプロバイダー環境にゲストとしてデプロイすることも、物理インフラストラクチャーにデプロイすることもできるため、アプリケーションは、主要なハードウェアアーキテクチャープラットフォームの革新的な機能を利用できます。

1.1. サポート対象のアーキテクチャー

Red Hat Enterprise Linux では、次のアーキテクチャーに対応します。

- AMD、Intel、および ARM 64 ビットアーキテクチャー

IBM Power Systems (リトルエンディアン)

- IBM Power System LC サーバー

- IBM Power System AC サーバー

- IBM Power System L サーバー

- 64 ビット IBM Z

IBM Power Server へのインストール手順は、IBM installation documentation を参照してください。システムで RHEL のインストールがサポートされていることを確認するには、https://catalog.redhat.com および https://access.redhat.com/articles/rhel-limits を参照してください。

1.2. システム要件

Red Hat Enterprise Linux を初めてインストールする場合は、インストールの前にシステム、ハードウェア、セキュリティー、メモリー、および RAID に関するガイドラインを確認することが推奨されます。詳細は、システム要件の参照 を参照してください。

システムを仮想ホストとして使用する場合は、仮想化に必要なハードウェア要件 を確認してください。

第2章 インストールの準備

Red Hat Enterprise Linux をインストールする前に、以下のセクションを参照してインストールのセットアップを準備します。

2.1. 推奨される手順

RHEL インストールの準備は、以下の手順で設定されます。

手順

- インストール方法を確認し、決定します。

- システム要件の確認

- インストール起動用メディアのオプションを確認します。

- 必要なインストール ISO イメージをダウンロードします。

- 起動可能なインストールメディアを作成します。

- インストールソース* を準備します。

*コンテンツ配信ネットワーク (CDN) を使用して必要なソフトウェアパッケージをダウンロードしていない場合は、Boot ISO (最小インストール) イメージにのみ必要です。

2.2. RHEL のインストール方法

Red Hat Enterprise Linux は、以下のいずれかの方法でインストールできます。

- GUI ベースのインストール

- システムまたはクラウドイメージベースのインストール

- 高度なインストール

本ガイドでは、ユーザーインターフェイス (GUI) を使用した RHEL のインストール方法を説明します。

GUI ベースのインストール

以下の GUI ベースのインストール方法から選択できます。

- カスタマーポータルから ISO イメージを使用した RHEL のインストール:カスタマーポータルから DVD ISO イメージファイルをダウンロードして Red Hat Enterprise Linux をインストールします。登録は、GUI インストールの完了後に行われます。このインストール方法は、キックスタートでも対応しています。

コンテンツ配信ネットワークからの RHEL の登録およびインストールコンテンツ配信ネットワーク (CDN) から、システムを登録し、サブスクリプションを割り当て、Red Hat Enterprise Linux をインストールします。このインストール方法は、Boot ISO イメージファイルおよび DVD ISO イメージファイルに対応します。ただし、Boot ISO イメージファイルのインストールソースのデフォルトは CDN であるため、Boot ISO イメージファイルが推奨されます。システムの登録後、インストーラーは CDN からパッケージをダウンロードしてインストールします。このインストール方法は、キックスタートでも対応しています。

重要GUI で、特定の要件に合わせて RHEL インストールをカスタマイズできます。特定の環境要件 (Red Hat への接続、ソフトウェア選択、パーティション設定、セキュリティーなど) の追加オプションを選択できます。詳細は、インストールのカスタマイズ を参照してください。

システムまたはクラウドイメージベースのインストール

システムまたはクラウドイメージベースのインストール方法は、仮想環境およびクラウド環境でのみ使用できます。

システムまたはクラウドイメージベースのインストールを実行するには、Red Hat Image Builder を使用します。Image Builder は、クラウドデプロイメントのシステムイメージを含む、Red Hat Enterprise Linux のカスタマイズされたシステムイメージを作成します。

Image Builder を使用して RHEL をインストールする方法の詳細は、RHEL システムイメージのカスタマイズ を参照してください。

高度なインストール

以下の高度なインストール方法から選択できます。

- キックスタートを使用した RHEL の自動インストールを実行します。キックスタートは、ファイルの要件と設定をすべて指定して、オペレーティングシステムのインストールに役立つ自動化されたプロセスです。キックスタートファイルには、RHEL インストールオプション (タイムゾーン、ドライブパーティション、インストールするパッケージなど) が含まれます。事前に準備したキックスタートファイルを使用すると、ユーザーによる操作を必要とせずにインストールが完了します。これは、一度に多数のシステムに Red Hat Enterprise Linux をデプロイする場合に便利です。

- VNC を使用したリモート RHEL インストールの実行RHEL インストールプログラムは、2 つの Virtual Network Computing (VNC) インストールモードを提供します。Direct および Connect です。接続が確立されると、2 つのモードに違いはありません。選択するモードは、環境によって異なります。

- PXE を使用して、ネットワークから RHEL をインストールPXE (Preboot eXecution Environment) を使用するネットワークインストールでは、インストールサーバーへのアクセスがあるシステムに、Red Hat Enterprise Linux をインストールできます。ネットワークインストールには、少なくとも 2 つのシステムが必要です。

関連情報

- 高度なインストール方法の詳細は、高度な RHEL 8 インストールの実行 を参照してください。

2.3. システム要件

Red Hat Enterprise Linux を初めてインストールする場合は、インストールの前にシステム、ハードウェア、セキュリティー、メモリー、および RAID に関するガイドラインを確認することが推奨されます。詳細は、システム要件の参照 を参照してください。

システムを仮想ホストとして使用する場合は、仮想化に必要なハードウェア要件 を確認してください。

2.4. インストール起動用メディアオプション

Red Hat Enterprise Linux インストールプログラムを起動する方法はいくつかあります。

- フルインストール用 DVD または USB フラッシュドライブ

- DVD ISO イメージを使用して、フルインストールの DVD または USB フラッシュドライブを作成します。ソフトウェアパッケージをインストールする場合は、DVD または USB フラッシュドライブを、ブートデバイスおよびインストールソースとして使用できます。

- 最小インストール用の DVD、CD、または USB フラッシュドライブ

- 最小インストール用 CD、DVD、または USB フラッシュドライブは、Boot ISO イメージを使用して作成されます。これには、システムを起動し、インストールプログラムを開始するのに最低限必要なファイルのみが含まれます。

コンテンツ配信ネットワーク (CDN) を使用して必要なソフトウェアパッケージをダウンロードする場合は、Boot ISO イメージに、必要なソフトウェアパッケージを含むインストールソースが必要です。

- PXE サーバー

- PXE (preboot execution environment) サーバーを使用すると、ネットワーク経由でインストールプログラムを起動できます。システムが起動したら、ローカルのハードドライブやネットワーク経由など、別のインストールソースからインストールを完了します。

- Image Builder

- Image Builder を使用すると、システムおよびクラウドイメージをカスタマイズして、仮想環境およびクラウド環境に Red Hat Enterprise Linux をインストールできます。

2.5. インストール ISO イメージの種類

Red Hat カスタマーポータルでは、2 種類の Red Hat Enterprise Linux 8 インストール ISO イメージが利用できます。

- DVD ISO イメージファイル

これは、BaseOS リポジトリーおよび AppStream リポジトリーを含む完全なインストールプログラムです。DVD ISO ファイルを使用すると、追加のリポジトリーにアクセスせずにインストールを完了できます。

重要Binary DVD は、64 ビットの IBM Z でもご利用になれます。SCSI DVD ドライブを使用してインストールプログラムを起動したり、インストールソースとしても使用できます。

- Boot ISO イメージファイル

Boot ISO イメージは、以下のような方法で RHEL をインストールするのに使用できる最小限のインストールです。

- コンテンツ配信ネットワーク (CDN) から RHEL を登録してインストールする場合。

- ソフトウェアパッケージをインストールするのに、BaseOS リポジトリーおよび AppStream リポジトリーにアクセスする必要がある最小限のイメージとして。リポジトリーは、Red Hat カスタマーポータル からダウンロードできる DVD ISO イメージに含まれます。DVD ISO イメージをダウンロードしてデプロイメントし、リポジトリーにアクセスします。

次の表に、サポートされているアーキテクチャーで利用可能なイメージに関する情報を示します。

表2.1 起動用およびインストール用のイメージ

| アーキテクチャー | インストール DVD | ブート DVD |

|---|---|---|

| AMD64 および Intel 64 | x86_64 DVD ISO イメージファイル | x86_64 Boot ISO イメージファイル |

| ARM 64 | AArch64 DVD ISO イメージファイル | AArch64 Boot ISO イメージファイル |

| IBM POWER | ppc64le DVD ISO イメージファイル | ppc64le Boot ISO イメージファイル |

| 64 ビット IBM Z | s390x DVD ISO イメージファイル | s390x Boot ISO イメージファイル |

2.6. RHEL インストール ISO イメージのダウンロード

Red Hat Enterprise Linux は、Red Hat カスタマーポータル にアクセスするか、curl コマンドを使用してダウンロードできます。

2.6.1. インストール ISO イメージの種類

Red Hat カスタマーポータルでは、2 種類の Red Hat Enterprise Linux 8 インストール ISO イメージが利用できます。

- DVD ISO イメージファイル

これは、BaseOS リポジトリーおよび AppStream リポジトリーを含む完全なインストールプログラムです。DVD ISO ファイルを使用すると、追加のリポジトリーにアクセスせずにインストールを完了できます。

重要Binary DVD は、64 ビットの IBM Z でもご利用になれます。SCSI DVD ドライブを使用してインストールプログラムを起動したり、インストールソースとしても使用できます。

- Boot ISO イメージファイル

Boot ISO イメージは、以下のような方法で RHEL をインストールするのに使用できる最小限のインストールです。

- コンテンツ配信ネットワーク (CDN) から RHEL を登録してインストールする場合。

- ソフトウェアパッケージをインストールするのに、BaseOS リポジトリーおよび AppStream リポジトリーにアクセスする必要がある最小限のイメージとして。リポジトリーは、Red Hat カスタマーポータル からダウンロードできる DVD ISO イメージに含まれます。DVD ISO イメージをダウンロードしてデプロイメントし、リポジトリーにアクセスします。

次の表に、サポートされているアーキテクチャーで利用可能なイメージに関する情報を示します。

表2.2 起動用およびインストール用のイメージ

| アーキテクチャー | インストール DVD | ブート DVD |

|---|---|---|

| AMD64 および Intel 64 | x86_64 DVD ISO イメージファイル | x86_64 Boot ISO イメージファイル |

| ARM 64 | AArch64 DVD ISO イメージファイル | AArch64 Boot ISO イメージファイル |

| IBM POWER | ppc64le DVD ISO イメージファイル | ppc64le Boot ISO イメージファイル |

| 64 ビット IBM Z | s390x DVD ISO イメージファイル | s390x Boot ISO イメージファイル |

2.6.2. カスタマーポータルから ISO イメージのダウンロード

Boot ISO イメージは、システムの登録、サブスクリプションの割り当て、およびコンテンツ配布ネットワーク (CDN) からの RHEL のインストールに対応する最小限のイメージファイルです。DVD ISO イメージファイルには、リポジトリーとソフトウェアパッケージがすべて含まれ、追加設定は必要ありません。

前提条件

- アクティブな Red Hat サブスクリプションがある。

- Product Downloads の Red Hat カスタマーポータルの Product Downloads セクションにログインしている。

手順

ブラウザーを開いて https://access.redhat.com/downloads/content/rhel にアクセスします。

このページには、Red Hat Enterprise Linux の人気のあるダウンロードがリストされています。

- 必要な ISO イメージの横にある 今すぐダウンロードする をクリックします。

目的のバージョンの RHEL がリストにない場合は、

All Red Hat Enterprise Linux Downloadsをクリックします。Product Variant ドロップダウンメニューから、必要なバリアントとアーキテクチャーを選択します。

- オプション: パッケージ タブを選択して、選択したバリアントに含まれるパッケージを表示します。Red Hat Enterprise Linux 8 で利用可能なパッケージについては、パッケージマニフェスト ドキュメントを参照してください。

Version ドロップダウンメニューから、ダウンロードする RHEL バージョンを選択します。デフォルトでは、選択したバリアントとアーキテクチャーの最新バージョンが選択されています。

Product Software タブには以下のようなイメージファイルがあります。

- Red Hat Enterprise Linux Binary DVD イメージ

- Red Hat Enterprise Linux Boot ISO イメージ

他のイメージ (たとえば、事前設定されている仮想マシンイメージ) も利用できます。

- 必要な ISO イメージの横にある 今すぐダウンロードする をクリックします。

2.6.3. curl で ISO イメージのダウンロード

curl ツールを使用すると、コマンドラインを使用して Web から必要なファイルを取得し、ローカルに保存するか、必要に応じて別のプログラムにパイプできます。本セクションでは、curl コマンドを使用してインストールイメージをダウンロードする方法を説明します。

前提条件

curlパッケージおよびjqパッケージがインストールされている。Linux ディストリビューションで

yumまたはaptを使用していない場合、もしくは Linux を使用していない場合は、curl の Web サイト から、最適なソフトウェアパッケージをダウンロードします。- Red Hat API トークン から生成したオフライントークンがある。

- 製品のダウンロード からダウンロードするファイルのチェックサムがある。

手順

以下の内容で bash ファイルを作成します。

#!/bin/bash # set the offline token and checksum parameters offline_token="<offline_token>" checksum=<checksum> # get an access token access_token=$(curl https://sso.redhat.com/auth/realms/redhat-external/protocol/openid-connect/token -d grant_type=refresh_token -d client_id=rhsm-api -d refresh_token=$offline_token | jq -r '.access_token') # get the filename and download url image=$(curl -H "Authorization: Bearer $access_token" "https://api.access.redhat.com/management/v1/images/$checksum/download") filename=$(echo $image | jq -r .body.filename) url=$(echo $image | jq -r .body.href) # download the file curl $url -o $filename

上記のテキストで、<offline_token> を Red Hat API ポータルから収集したトークンに置き換え、<checksum> を 製品ダウンロード ページから取得したチェックサム値に置き換えます。

このファイルを実行可能な状態にします。

$ chmod u+x FILEPATH/FILENAME.sh

ターミナルウィンドウを開き、bash ファイルを実行します。

$ ./FILEPATH/FILENAME.sh

ネットワークのベストプラクティスと一貫性のあるパスワード管理を使用します。

- パスワードや認証情報をプレーンテキストに保存しないでください。

- トークンを不正使用から安全に保護してください。

2.7. 起動可能な RHEL 用インストールメディアの作成

本セクションでは、ダウンロードした ISO イメージファイルを使用して、USB、DVD、CD などの起動可能な物理インストールメディアを作成する方法を説明します。ISO イメージのダウンロードの詳細は、インストール用 ISO イメージのダウンロード を参照してください。

デフォルトでは、インストールメデイアで inst.stage2= 起動オプションが使用され、特定のラベル (たとえば inst.stage2=hd:LABEL=RHEL8\x86_64) に設定されます。ランタイムイメージが含まれるファイルシステムのデフォルトのラベルを変更します。インストールシステムの起動手順をカスタマイズする場合は、このラベルが正しい値に設定されていることを確認します。

2.7.1. インストール起動用メディアオプション

Red Hat Enterprise Linux インストールプログラムを起動する方法はいくつかあります。

- フルインストール用 DVD または USB フラッシュドライブ

- DVD ISO イメージを使用して、フルインストールの DVD または USB フラッシュドライブを作成します。ソフトウェアパッケージをインストールする場合は、DVD または USB フラッシュドライブを、ブートデバイスおよびインストールソースとして使用できます。

- 最小インストール用の DVD、CD、または USB フラッシュドライブ

- 最小インストール用 CD、DVD、または USB フラッシュドライブは、Boot ISO イメージを使用して作成されます。これには、システムを起動し、インストールプログラムを開始するのに最低限必要なファイルのみが含まれます。

コンテンツ配信ネットワーク (CDN) を使用して必要なソフトウェアパッケージをダウンロードする場合は、Boot ISO イメージに、必要なソフトウェアパッケージを含むインストールソースが必要です。

- PXE サーバー

- PXE (preboot execution environment) サーバーを使用すると、ネットワーク経由でインストールプログラムを起動できます。システムが起動したら、ローカルのハードドライブやネットワーク経由など、別のインストールソースからインストールを完了します。

- Image Builder

- Image Builder を使用すると、システムおよびクラウドイメージをカスタマイズして、仮想環境およびクラウド環境に Red Hat Enterprise Linux をインストールできます。

2.7.2. 起動可能な DVD または CD の作成

起動可能なインストール DVD または CD は、ディスク書き込みソフトウェアや、CD/DVD バーナーを使用して作成できます。ISO イメージファイルから DVD または CD を作成する手順は、オペレーティングシステムや、インストールされているディスク書き込みソフトウェアにより大きく異なります。CD または DVD への ISO イメージファイルの書き込み方法は、お使いの書き込みソフトウェアのドキュメントを参照してください。

DVD ISO イメージ (フルインストール) または Boot ISO イメージ (最小インストール) のいずれかを使用して、起動可能な DVD または CD を作成できます。ただし、DVD ISO イメージが 4.7 GB より大きくなり、1 層または 2 層 DVD に収まらない場合があります。作業を続行する前に、DVD ISO イメージファイルのサイズを確認してください。DVD ISO イメージを使用して起動可能なインストールメディアを作成する場合は、USB フラッシュドライブが推奨されます。

2.7.3. Linux で起動可能な USB デバイスの作成

起動可能な USB デバイスを作成し、それを使用して他のマシンに Red Hat Enterprise Linux をインストールできます。

この手順を実行すると、USB ドライブに保存しておいたデータはすべて警告なしに上書きされます。データをバックアップするか、空のフラッシュドライブを使用してください。起動可能な USB ドライブは、データの保存には使用できません。

前提条件

- インストール用 ISO イメージのダウンロード の説明に従って、インストール用 ISO イメージをダウンロードしている。

- ISO イメージに十分な容量の USB フラッシュドライブがある。必要なサイズはさまざまですが、推奨される USB サイズは 8 GB です。

手順

- USB フラッシュドライブをシステムに接続します。

ターミナルウィンドウを開き、最近のイベントのログを表示します。

$ dmesg|tail

このログの下部に、接続している USB フラッシュドライブから出力されたメッセージが表示されます。接続したデバイスの名前を記録してください。

root ユーザーとしてログインします。

$ su -

プロンプトに従い root パスワードを入力します。

ドライブに割り当てられているデバイスノードを見つけます。この例で使用されているドライブの名前は

sddです。# dmesg|tail [288954.686557] usb 2-1.8: New USB device strings: Mfr=0, Product=1, SerialNumber=2 [288954.686559] usb 2-1.8: Product: USB Storage [288954.686562] usb 2-1.8: SerialNumber: 000000009225 [288954.712590] usb-storage 2-1.8:1.0: USB Mass Storage device detected [288954.712687] scsi host6: usb-storage 2-1.8:1.0 [288954.712809] usbcore: registered new interface driver usb-storage [288954.716682] usbcore: registered new interface driver uas [288955.717140] scsi 6:0:0:0: Direct-Access Generic STORAGE DEVICE 9228 PQ: 0 ANSI: 0 [288955.717745] sd 6:0:0:0: Attached scsi generic sg4 type 0 [288961.876382] sd 6:0:0:0: sdd Attached SCSI removable disk

ISO イメージを USB デバイスに直接書き込みます。

# dd if=/image_directory/image.iso of=/dev/device

- /image_directory/image.iso を、ダウンロードした ISO イメージファイルへのフルパスに置き換えます。

device を、

dmesgコマンドで取得したデバイス名に置き換えます。この例では、ISO イメージのフルパスが

/home/testuser/Downloads/rhel-8-x86_64-boot.isoで、検出されたデバイス名がsddです。# dd if=/home/testuser/Downloads/rhel-8-x86_64-boot.iso of=/dev/sdd注記デバイス上のパーティション名ではなく、正しいデバイス名を使用していることを確認してください。パーティション名は、通常、数字の接尾辞が付いたデバイス名です。たとえば、

sddがデバイス名の場合、デバイスsdd上のパーティションの名前は、sdd1になります。

-

ddコマンドがデバイスへのイメージの書き込みを終了するのを待ちます。データ転送が完了すると、# プロンプトが表示されます。プロンプトが表示されたら、root アカウントからログアウトして、USB ドライブを取り外します。これで USB ドライブを起動デバイスとして使用する準備が整いました。

2.7.4. Windows で起動可能な USB デバイスの作成

さまざまなツールを使用して、Windows システムに起動可能な USB デバイスを作成できます。Red Hat は、https://github.com/FedoraQt/MediaWriter/releases からダウンロードできる Fedora Media Writer の使用を推奨します。Fedora Media Writer はコミュニティー製品であり、Red Hat のサポート対象外になる点に注意してください。このツールの問題は、https://github.com/FedoraQt/MediaWriter/issues から報告できます。

この手順を実行すると、USB ドライブに保存しておいたデータはすべて警告なしに上書きされます。データをバックアップするか、空のフラッシュドライブを使用してください。起動可能な USB ドライブは、データの保存には使用できません。

前提条件

- インストール用 ISO イメージのダウンロード の説明に従って、インストール用 ISO イメージをダウンロードしている。

- ISO イメージに十分な容量の USB フラッシュドライブがある。必要なサイズはさまざまですが、推奨される USB サイズは 8 GB です。

手順

- https://github.com/FedoraQt/MediaWriter/releases から Fedora Media Writer をダウンロードしてインストールします。

- USB フラッシュドライブをシステムに接続します。

- Fedora Media Writer を開きます。

- メイン画面で Custom Image をクリックして、ダウンロードしておいた Red Hat Enterprise Linux ISO イメージを選択します。

- Write Custom Image 画面で、使用するドライブを選択します。

- Write to disk をクリックします。起動用メディアの作成プロセスが開始します。プロセスが完了するまでドライブを抜かないでください。ISO イメージのサイズや、USB ドライブの書き込み速度により、この操作には数分かかる場合があります。

- 操作が完了したら、USB ドライブをアンマウントします。これで USB ドライブを起動デバイスとして使用する準備が整いました。

2.7.5. Mac OS X で起動可能な USB デバイスの作成

起動可能な USB デバイスを作成し、それを使用して他のマシンに Red Hat Enterprise Linux をインストールできます。

この手順を実行すると、USB ドライブに保存しておいたデータはすべて警告なしに上書きされます。データをバックアップするか、空のフラッシュドライブを使用してください。起動可能な USB ドライブは、データの保存には使用できません。

前提条件

- インストール用 ISO イメージのダウンロード の説明に従って、インストール用 ISO イメージをダウンロードしている。

- ISO イメージに十分な容量の USB フラッシュドライブがある。必要なサイズはさまざまですが、推奨される USB サイズは 8 GB です。

手順

- USB フラッシュドライブをシステムに接続します。

diskutil listコマンドでデバイスパスを特定します。デバイスパスの形式は/dev/disknumberです。numberはディスクの数になります。ディスク番号は、0 から始まります。通常、disk0は OS X リカバリーディスク、disk1はメインの OS X インストールになります。以下の例では、disk2が USB デバイスです。$ diskutil list /dev/disk0 #: TYPE NAME SIZE IDENTIFIER 0: GUID_partition_scheme *500.3 GB disk0 1: EFI EFI 209.7 MB disk0s1 2: Apple_CoreStorage 400.0 GB disk0s2 3: Apple_Boot Recovery HD 650.0 MB disk0s3 4: Apple_CoreStorage 98.8 GB disk0s4 5: Apple_Boot Recovery HD 650.0 MB disk0s5 /dev/disk1 #: TYPE NAME SIZE IDENTIFIER 0: Apple_HFS YosemiteHD *399.6 GB disk1 Logical Volume on disk0s1 8A142795-8036-48DF-9FC5-84506DFBB7B2 Unlocked Encrypted /dev/disk2 #: TYPE NAME SIZE IDENTIFIER 0: FDisk_partition_scheme *8.1 GB disk2 1: Windows_NTFS SanDisk USB 8.1 GB disk2s1

- NAME、TYPE、および SIZE の列をフラッシュドライブと比較し、USB フラッシュドライブを特定します。たとえば、NAME は、Finder ツールのフラッシュドライブアイコンのタイトルになります。この値は、フラッシュドライブの情報パネルの値と比較することもできます。

フラッシュドライブのファイルシステムボリュームをアンマウントします。

$ diskutil unmountDisk /dev/disknumber Unmount of all volumes on disknumber was successful

コマンドが完了すると、デスクトップからフラッシュドライブのアイコンが消えます。アイコンが消えない場合は、誤ったディスクを選択した可能性があります。誤ってシステムディスクのマウントを解除しようとすると、failed to unmount エラーが返されます。

ISO イメージをフラッシュドライブに書き込みます。

# sudo dd if=/path/to/image.iso of=/dev/rdisknumber

注記Mac OS X では、ブロック (

/dev/disk*) とキャラクターデバイス (/dev/rdisk*) の両方のファイルが各ストレージデバイスに提供されます。/dev/rdisknumberキャラクターデバイスにイメージを書き込む方が、/dev/disknumberブロックデバイスに書き込むよりも高速です。たとえば、

/Users/user_name/Downloads/rhel-8-x86_64-boot.isoファイルを/dev/rdisk2デバイスに書き込むには、以下のコマンドを実行します。# sudo dd if=/Users/user_name/Downloads/rhel-8-x86_64-boot.iso of=/dev/rdisk2

-

ddコマンドがデバイスへのイメージの書き込みを終了するのを待ちます。データ転送が完了すると、# プロンプトが表示されます。プロンプトが表示されたら、root アカウントからログアウトして、USB ドライブを取り外します。これで USB ドライブを起動デバイスとして使用する準備が整いました。

2.8. インストールソースの準備

Boot ISO イメージファイルには、リポジトリーやソフトウェアパッケージが含まれておらず、システムを起動し、インストールを開始するのに必要なインストールプログラムとツールのみが含まれます。本セクションでは、必要なリポジトリーおよびソフトウェアパッケージを含む DVD ISO イメージを使用して、Boot ISO イメージのインストールソースを作成する方法を説明します。

コンテンツ配信ネットワーク (CDN) から RHEL を登録してインストールしない場合に限り、Boot ISO イメージファイルにインストールソースが必要になります。

2.8.1. インストールソースの種類

最小限のブートイメージには、以下のいずれかのインストールソースを使用できます。

- DVD:DVD に DVD ISO イメージを書き込みます。DVD はインストールソース (ソフトウェアパッケージソース) として自動的に使用されます。

ハードドライブまたは USB ドライブ:DVD ISO イメージをドライブにコピーして、ドライブからソフトウェアパッケージをインストールするように、インストールプログラムを設定します。USB ドライブを使用する場合は、インストールを開始する前に、USB ドライブがシステムに接続されていることを確認してください。インストールプログラムは、インストールの開始後にメディアを検出することができません。

-

ハードドライブの制限: ハードドライブの DVD ISO イメージは、インストールプログラムがマウントできるファイルシステムを使用しているパーティションに置く必要があります。対応するファイルシステムは、

xfs、ext2、ext3、ext4、およびvfat (FAT32)となります。

警告Microsoft Windows システムで、ハードドライブをフォーマットする際に使用されるデフォルトのファイルシステムは NTFS です。exFAT ファイルシステムも利用できます。ただし、このファイルシステムは、いずれもインストール時に変更することができません。Microsoft Windows のインストールソースとして、ハードドライブまたは USB ドライブを作成する場合は、ドライブを FAT32 としてフォーマットするようにしてください。FAT32 ファイルシステムは、4 GiB を超えるファイルを保存できません。

Red Hat Enterprise Linux 8 では、ローカルのハードドライブのディレクトリーからインストールできます。これを行うには、DVD ISO イメージの内容をハードドライブのディレクトリーにコピーし、ISO イメージの代わりに、そのディレクトリーをインストールソースとして指定します。たとえば、

inst.repo=hd:<device>:<path to the directory>です。-

ハードドライブの制限: ハードドライブの DVD ISO イメージは、インストールプログラムがマウントできるファイルシステムを使用しているパーティションに置く必要があります。対応するファイルシステムは、

ネットワークの場所:DVD ISO イメージまたはインストールツリー (DVD ISO イメージから抽出したコンテンツ) をネットワーク上の場所にコピーし、次のプロトコルを使用して、ネットワーク経由でインストールを実行します。

- NFS:DVD ISO イメージは、ネットワークファイルシステム (NFS) 共有にあります。

- HTTPS、HTTP、または FTP の場合:インストールツリーは、HTTP、HTTPS、または FTP 経由でアクセス可能なネットワーク上にあります。

2.8.2. インストールソースの指定

インストールソースは、次のいずれかの方法で指定します。

- ユーザーインターフェイス:グラフィカルインストールの インストールソース 画面で、インストールソースを選択します。詳細は、インストールソースの設定 を参照してください。

- 起動オプションインストールソースを指定するカスタム起動オプションを設定します。詳細は、ブートオプションの設定 を参照してください。

- キックスタートファイル:キックスタートファイルでインストールコマンドを使用して、インストールファイルソースを指定します。詳細は、高度な RHEL 8 インストールの実行 を参照してください。

2.8.3. ネットワークインストール用のポート

次の表は、ネットワークベースの各種インストールにファイルを提供するためにサーバーで開く必要があるポートの一覧です。

表2.3 ネットワークインストール用のポート

| 使用プロトコル | 開くべきポート |

|---|---|

| HTTP | 80 |

| HTTPS | 443 |

| FTP | 21 |

| NFS | 2049、111、20048 |

| TFTP | 69 |

関連情報

2.8.4. NFS サーバーへのインストールソースの作成

この方法を使用して、物理メディアに接続しなくても、1 つのソースから複数のシステムをインストールできます。

前提条件

- Red Hat Enterprise Linux 8 を搭載したサーバーへの管理者レベルのアクセス権があり、このサーバーが、インストールするシステムと同じネットワーク上にある。

- Binary DVD イメージをダウンロードしている。詳しくは、インストール ISO イメージのダウンロード を参照してください。

- イメージファイルから、起動可能な CD、DVD、または USB デバイスを作成している。詳細は、インストールメディアの作成 を参照してください。

- ファイアウォールにより、インストールしようとしているシステムがリモートインストールソースにアクセスできることを確認している。詳細については、ネットワークベースのインストール用のポート を参照してください。

手順

nfs-utilsパッケージをインストールします。# yum install nfs-utils

- DVD ISO イメージを、NFS サーバーのディレクトリーにコピーします。

テキストエディターで

/etc/exportsファイルを開き、以下の構文の行を追加します。/exported_directory/ clients

- /exported_directory/ を、ISO イメージが含まれるディレクトリーのフルパスに置き換えます。

clients を次のいずれかに置き換えます。

- ターゲットシステムのホスト名または IP アドレス

- すべてのターゲットシステムが ISO イメージへのアクセスに使用できるサブネットワーク

-

NFS サーバーへのネットワークアクセスを持つすべてのシステムが ISO イメージを使用できるようにするためのアスタリスク記号 (

*)

このフィールドの形式に関する詳細は、

exports(5)の man ページを参照してください。たとえば、

/rhel8-install/ディレクトリーを、すべてのクライアントに対する読み取り専用として使用できるようにする基本設定は次のようになります。/rhel8-install *

-

/etc/exportsファイルを保存して、テキストエディターを終了します。 nfs サービスを起動します。

# systemctl start nfs-server.service

/etc/exportsファイルを変更する前に サービスが稼働していた場合は、NFS サーバーの設定をリロードします。# systemctl reload nfs-server.service

ISO イメージは、NFS 経由でアクセス可能になり、インストールソースとして使用できるようになりました。

インストールソースを設定するには、プロトコルに nfs: を使用し、サーバーのホスト名または IP アドレス、コロン記号 (:)、および ISO イメージを保存しているディレクトリーを指定します。たとえば、サーバーのホスト名が myserver.example.com で、ISO イメージを /rhel8-install/ に保存した場合、指定するインストールソースは nfs:myserver.example.com:/rhel8-install/ となります。

2.8.5. HTTP または HTTPS を使用するインストールソースの作成

インストールツリー (DVD ISO イメージから抽出したコンテンツと、有効な .treeinfo ファイル含むディレクトリー) を使用したネットワークベースのインストール用のインストールソースを作成できます。インストールソースには、HTTP、または HTTPS でアクセスします。

前提条件

- Red Hat Enterprise Linux 8 を搭載したサーバーへの管理者レベルのアクセス権があり、このサーバーが、インストールするシステムと同じネットワーク上にある。

- Binary DVD イメージをダウンロードしている。詳しくは、インストール ISO イメージのダウンロード を参照してください。

- イメージファイルから、起動可能な CD、DVD、または USB デバイスを作成している。詳細は、インストールメディアの作成 を参照してください。

- ファイアウォールにより、インストールしようとしているシステムがリモートインストールソースにアクセスできることを確認している。詳細については、ネットワークベースのインストール用のポート を参照してください。

-

httpdパッケージがインストールされている。 -

httpsインストールソースを使用すると、mod_sslパッケージがインストールされます。

Apache Web サーバー設定で SSL セキュリティーが有効になっている場合は、TLSv1.3 プロトコルを有効にすることが推奨されます。デフォルトでは、TLSv1.2 が有効になっており、TLSv1 (LEGACY) プロトコルを使用できます。

自己署名証明書付きの HTTPS サーバーを使用する場合は、noverifyssl オプションを指定してインストールプログラムを起動する必要があります。

手順

- HTTP(S) サーバーに DVD ISO イメージをコピーします。

DVD ISO イメージをマウントするのに適したディレクトリーを作成します。以下はその例です。

# mkdir /mnt/rhel8-install/

DVD ISO イメージをディレクトリーにマウントします。

# mount -o loop,ro -t iso9660 /image_directory/image.iso /mnt/rhel8-install//image_directory/image.iso を DVD ISO イメージへのパスに置き換えます。

マウントされたイメージから、HTTP(S) サーバーの root にファイルをコピーします。

# cp -r /mnt/rhel8-install/ /var/www/html/

このコマンドにより、イメージに含まれるファイルが保存される

/var/www/html/rhel8-install/ディレクトリーを作成します。他の一部のコピー方法は、有効なインストールソースに必要な.treeinfoファイルを省略する可能性があることに注意してください。この手順で示されているように、ディレクトリー全体に対してcpコマンドを入力すると、.treeinfoが正しくコピーされます。httpdサービスを起動します。# systemctl start httpd.service

これにより、インストールツリーにアクセスできるようになり、インストールソースとして使用できるようになります。

注記インストールソースを設定するには、プロトコルに

http://またはhttps://を使用して、サーバーのホスト名または IP アドレス、および ISO イメージのファイルを保存するディレクトリー (HTTP サーバーの root への相対パス) を指定します。たとえば、HTTP を使用し、サーバーのホスト名がmyserver.example.comで、イメージのファイルが/var/www/html/rhel8-install/にコピーされた場合、指定するインストールソースはhttp://myserver.example.com/rhel8-install/となります。

関連情報

2.8.6. FTP を使用するインストールソースの作成

インストールツリー (DVD ISO イメージから抽出したコンテンツと、有効な .treeinfo ファイル含むディレクトリー) を使用したネットワークベースのインストール用のインストールソースを作成できます。インストールソースには、FTP を使用してアクセスします。

前提条件

- Red Hat Enterprise Linux 8 を搭載したサーバーへの管理者レベルのアクセス権があり、このサーバーが、インストールするシステムと同じネットワーク上にある。

- Binary DVD イメージをダウンロードしている。詳しくは、インストール ISO イメージのダウンロード を参照してください。

- イメージファイルから、起動可能な CD、DVD、または USB デバイスを作成している。詳細は、インストールメディアの作成 を参照してください。

- ファイアウォールにより、インストールしようとしているシステムがリモートインストールソースにアクセスできることを確認している。詳細については、ネットワークベースのインストール用のポート を参照してください。

-

vsftpdパッケージがインストールされている。

手順

必要に応じて、

/etc/vsftpd/vsftpd.conf設定ファイルをテキストエディターで開いて編集します。-

anonymous_enable=NOの行をanonymous_enable=YESに変更します。 -

write_enable=YESの行をwrite_enable=NOに変更します。 pasv_min_port=<min_port>およびpasv_max_port=<max_port>の行を追加します。<min_port> と <max_port> を、FTP サーバーがパッシブモードで使用するポート番号の範囲 (10021と10031など) に置き換えます。この手順は、各種のファイアウォール/NAT 設定を採用するネットワーク環境で必要になる可能性があります。

オプション: カスタム変更を設定に追加します。利用可能なオプションは、vsftpd.conf(5) の man ページを参照してください。この手順では、デフォルトのオプションが使用されていることを前提としています。

警告vsftpd.confファイルで SSL/TLS セキュリティーを設定している場合は、TLSv1 プロトコルのみを有効にし、SSLv2 と SSLv3 は無効にしてください。POODLE SSL 脆弱性 (CVE-2014-3566) の影響を受けないようにするためです。詳細は、https://access.redhat.com/solutions/1234773 を参照してください。

-

サーバーのファイアウォールを設定します。

ファイアウォールを有効にします。

# systemctl enable firewalld

ファイアウォールを起動します。

# systemctl start firewalld

前の手順で設定した FTP ポートとポート範囲を許可するようにファイアウォールを設定します。

# firewall-cmd --add-port min_port-max_port/tcp --permanent # firewall-cmd --add-service ftp --permanent

<min_port> と <max_port> を

/etc/vsftpd/vsftpd.conf設定ファイルに入力したポート番号に置き換えます。ファイアウォールをリロードして、新しいルールを適用します。

# firewall-cmd --reload

- DVD ISO イメージを FTP サーバーにコピーします。

DVD ISO イメージをマウントするのに適したディレクトリーを作成します。以下はその例です。

# mkdir /mnt/rhel8-install

DVD ISO イメージをディレクトリーにマウントします。

# mount -o loop,ro -t iso9660 /image-directory/image.iso /mnt/rhel8-install/image-directory/image.isoを DVD ISO イメージへのパスに置き換えます。マウントされたイメージから、FTP サーバーのルートにファイルをコピーします。

# mkdir /var/ftp/rhel8-install # cp -r /mnt/rhel8-install/ /var/ftp/

このコマンドは、イメージに含まれるファイルが保存される

/var/ftp/rhel8-install/ディレクトリーを作成します。一部のコピー方法は、有効なインストールソースに必要な.treeinfoファイルを省略できることに注意してください。この手順で示されているように、ディレクトリー全体に対してcpコマンドを入力しても、.treeinfoが正しくコピーされます。正しい SELinux コンテキストとアクセスモードが、コピーされたコンテンツに設定されていることを確認します。

# restorecon -r /var/ftp/rhel8-install # find /var/ftp/rhel8-install -type f -exec chmod 444 {} \; # find /var/ftp/rhel8-install -type d -exec chmod 755 {} \;vsftpdサービスを開始します。# systemctl start vsftpd.service

/etc/vsftpd/vsftpd.confファイルを変更する前から、このサービスがすでに実行されていた場合は、サービスを再起動して必ず編集後のファイルを読み込ませてください。# systemctl restart vsftpd.service

vsftpdサービスを有効にして、システムの起動プロセス時に開始するようにします。# systemctl enable vsftpd

これにより、インストールツリーにアクセスできるようになり、インストールソースとして使用できるようになります。

注記インストールソースを設定するには、プロトコルに

ftp://を使用して、サーバーのホスト名または IP アドレス、および ISO イメージのファイルを保存するディレクトリー (FTP サーバーの root への相対パス) を指定します。たとえば、サーバーのホスト名がmyserver.example.comで、イメージからコピーしたファイルを/var/ftp/rhel8-install/に置いた場合、指定するインストールソースはftp://myserver.example.com/rhel8-install/となります。

2.8.7. インストールソースとしてのハードドライブの準備

このモジュールでは、ext2、ext3、ext4、または XFS ファイルシステムのハードドライブをインストールソースとして使用して RHEL をインストールする方法を説明します。この方法は、ネットワークアクセスや光学ドライブがないシステムに使用できます。ハードドライブのインストールではインストール DVD の ISO イメージを使用します。ISO イメージは、DVD のコンテンツの完全なコピーが含まれるファイルです。ハードドライブにこのファイルが存在すると、インストールプログラムの起動時に、インストールソースとしてハードドライブを選択できます。

-

Windows オペレーティングシステムでハードドライブパーティションのファイルシステムを確認するには、

Disk Managementツールを使用します。 -

Linux オペレーティングシステムでハードドライブパーティションのファイルシステムを確認するには、

partedツールを使用します。

LVM(論理ボリューム管理) パーティションでは、ISO ファイルは使用できません。

手順

Red Hat Enterprise Linux インストール DVD の ISO イメージをダウンロードします。あるいは、物理メディアに DVD がある場合は、Linux システムで以下のコマンドを使用して ISO のイメージを作成できます。

dd if=/dev/dvd of=/path_to_image/name_of_image.iso

ここで、dvd は DVD ドライブのデバイス名、name_of_image は作成する ISO イメージファイルに指定する名前、path_to_image はイメージを格納するシステム上の場所へのパスになります。

- ISO イメージをシステムのハードドライブまたは USB ドライブにコピーアンドペーストします。

SHA256チェックサムプログラムを使用して、コピーした ISO イメージが健全であることを確認します。さまざまなオペレーティングシステム用に、多くの SHA256 チェックサムプログラムが利用できます。Linux システムで、以下を実行します。$ sha256sum /path_to_image/name_of_image.iso

ここで、name_of_image は ISO イメージファイルの名前です。

SHA256チェックサムプログラムは、ハッシュ と呼ばれる 64 文字の文字列を表示します。このハッシュを、Red Hat カスタマーポータルの ダウンロード ページにあるこの特定のイメージに表示されるハッシュと比較します。2 つのハッシュは同一でなければなりません。インストールを開始する前に、カーネルコマンドラインで HDD インストールソースを指定します。

inst.repo=hd:<device>:/path_to_image/name_of_image.iso

第3章 スタートガイド

インストールを開始するには、まず起動メニューと利用可能な起動オプションを確認します。次に、選択した内容に応じて、インストールを起動します。

3.1. インストールの起動

起動可能なメディアを作成したら、Red Hat Enterprise Linux インストールを起動する準備ができました。

3.1.1. 起動メニュー

Red Hat Enterprise Linux の起動メニューは、システムが起動メディアの読み込みを完了すると、GRand Unified Bootloader version 2 (GRUB2) を使用して表示されます。

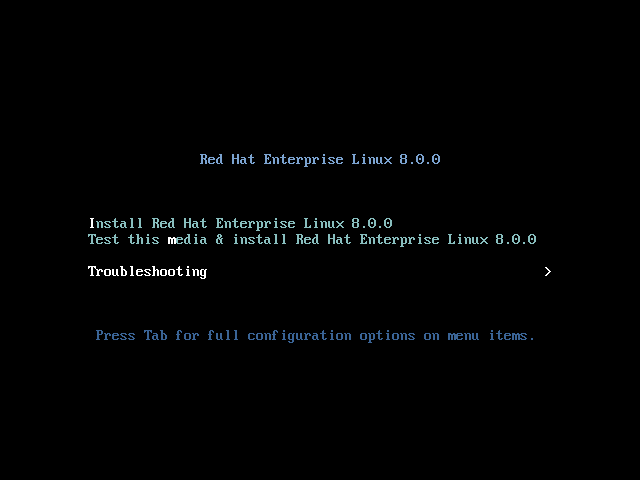

図3.1 Red Hat Enterprise Linux 起動メニュー

起動メニューには、インストールプログラムを起動する以外に、複数のオプションがあります。60 秒以内に選択しないと、デフォルトの起動オプション (白で強調表示されているもの) が実行します。別のオプションを選択する場合は、キーボードの矢印キーで選択し、Enter を押します。

特定のメニューエントリーの起動オプションをカスタマイズできます。

-

BIOS ベースのシステムの場合:Tab キーを押して、コマンドラインにカスタム起動オプションを追加します。Esc キーを押して

boot:プロンプトにアクセスすることもできますが、必要な起動オプションは事前設定されていません。このシナリオでは、その他の起動オプションを使用する前に、Linux オプションを常に指定する必要があります。 - UEFI ベースのシステムの場合:e キーを押して、コマンドラインにカスタム起動オプションを追加します。準備ができたら Ctrl+X を押して、修正したオプションを起動します。

表3.1 起動メニューオプション

| 起動メニューオプション | 説明 |

|---|---|

| Red Hat Enterprise Linux 8 のインストール | このオプションは、グラフィカルなインストールプログラムを使用して Red Hat Enterprise Linux をインストールする場合に使用します。詳細は、カスタマーポータルから ISO イメージを使用した RHEL のインストール を参照してください。 |

| このメディアをテストし、Red Hat Enterprise Linux 8 をインストールします。 | このオプションは、インストールメディアの整合性を確認する場合に使用します。詳細は、ブートメディアの検証 を参照してください。 |

| Troubleshooting > | このオプションは、インストールに関するさまざまな問題を解決する場合に使用します。Enter を押して、そのコンテンツを表示します。 |

表3.2 トラブルシューティングのオプション

| トラブルシューティングのオプション | 説明 |

|---|---|

| Troubleshooting > Install Red Hat Enterprise Linux 8 in basic graphics mode | このオプションを使用すると、インストールプログラムがビデオカード用に適切なドライバーを読み込むことができない場合でも、グラフィカルモードで Red Hat Enterprise Linux をインストールします。Install Red Hat Enterprise Linux 8 オプションの使用時に画面が歪んでいる場合は、システムを再起動してこのオプションを使用します。詳細は、グラフィカルインストールにブートできない を参照してください。 |

| Troubleshooting > Rescue a Red Hat Enterprise Linux system | このオプションは、起動を妨げる問題を修復する場合に使用します。詳細は、レスキューモードの使用 を参照してください。 |

| Troubleshooting > Run a memory test | このオプションは、システムでメモリーテストを実行する場合に使用します。Enter を押して、そのコンテンツを表示します。詳細は、memtest86 を参照してください。 |

| Troubleshooting > Boot from local drive | このオプションは、最初にインストールしたディスクからシステムを起動する場合に使用します。誤ってこのディスクを起動した場合は、このオプションを使用して、インストールプログラムを起動せずにすぐにハードディスクから起動します。 |

3.1.2. 起動オプションの入力

起動オプションには、等号 (=) が付いているものと、付けていないものがあります。ブートオプションはブートコマンドラインに追加され、スペースで区切って複数のオプションを追加できます。インストールプログラムに固有の起動オプションは、常に inst から始まります。

- 等号 (=) 記号を使用するオプション

-

起動オプションに、

=記号を使用する値を指定する必要があります。たとえば、inst.vncpassword=オプションには値 (この場合はパスワード) を指定する必要があります。この例の正しい構文はinst.vncpassword=passwordです。 - 等号 (=) 記号を使用しないオプション

-

この起動オプションでは、値またはパラメーターを使用できません。たとえば、

rd.live.checkオプションでは、インストール開始前にインストールメディアの検証が強制されます。インストールプログラムは、このブートオプションが存在すると検証を実行します。ブートオプションが存在しないと、検証はスキップされます。

3.1.3. BIOS で boot: プロンプトの編集

boot: プロンプトを使用すると、最初のオプションは、読み込むインストールプログラムのイメージファイルを常に指定する必要があります。ほとんどの場合、このイメージはキーワードを使用して指定できます。要件に応じて、追加オプションを指定できます。

前提条件

- 起動可能なインストールメディア (USB、CD、または DVD) を作成している。

- メディアからインストールを起動し、起動メニュー画面が開いている。

手順

- ブートメニューが開いたら、キーボードの Esc キーを押します。

-

boot:プロンプトにアクセスできるようになります。 - キーボードの Tab キーを押して、ヘルプコマンドを表示します。

-

キーボードの Enter キーを押して、オプションでインストールを開始します。

boot:プロンプトから起動メニュー画面に戻るには、システムを再起動して、インストールメディアから再度起動します。

boot: プロンプトでは、dracut カーネルオプションも使用できます。利用可能なオプションの一覧は、dracut.cmdline(7) の man ページを参照してください。

3.1.4. > プロンプトを使用して事前定義されたブートオプションの編集

BIOS ベースの AMD64 および Intel64 システムでは、> プロンプトを使用して、事前定義されたブートオプションを編集できます。オプションの完全なセットを表示するには、ブートメニューから Test this media and install RHEL 8 を選択します。

前提条件

- 起動可能なインストールメディア (USB、CD、または DVD) を作成している。

- メディアからインストールを起動し、起動メニュー画面が開いている。

手順

-

ブートメニューでオプションを選択し、キーボードの Tab キーを押します。

>プロンプトにアクセスし、利用可能なオプションを表示します。 -

>プロンプトに必要なオプションを追加します。 - Enter を押してインストールを開始します。

- Esc キーを押して編集をキャンセルし、ブートメニューに戻ります。

3.1.5. UEFI ベースのシステムの GRUB2 メニューの編集

GRUB2 メニューは、UEFI ベースの AMD64、Intel 64、および 64 ビット ARM システムで利用できます。

前提条件

- 起動可能なインストールメディア (USB、CD、または DVD) を作成している。

- メディアからインストールを起動し、起動メニュー画面が開いている。

手順

- ブートメニューウィンドウから必要なオプションを選択し、e を押します。

-

UEFI システムでは、カーネルコマンドラインは

linuxefiで始まります。カーソルをlinuxefiカーネルコマンドラインの最後に移動します。 -

必要に応じてパラメーターを編集します。たとえば、1 つ以上のネットワークインターフェイスを設定するには、

linuxefiカーネルコマンドラインの最後にip=パラメーターを追加し、その後に必要な値を追加します。 - 編集が終了したら、Ctrl + X を押して、指定したオプションを使用してインストールを開始します。

3.1.6. USB、CD、または DVD からのインストールの起動

以下の手順に従って、USB、CD、または DVD を使用して Red Hat Enterprise Linux のインストールを起動します。次の手順は一般的なものです。具体的な手順は、ハードウェアの製造元のドキュメントを参照してください。

前提条件

起動可能なインストールメディア (USB、CD、または DVD) を作成している。詳細は、起動可能な DVD または CD の作成 を参照してください。

手順

- Red Hat Enterprise Linux をインストールするシステムの電源を切ります。

- システムからドライブを切断します。

- システムの電源を入れます。

- 起動可能なインストールメディア (USB、DVD、または CD) を挿入します。

- システムの電源は切りますが、ブートメディアは取り出さないでください。

システムの電源を入れます。

注記メディアから起動するため特定のキーやキーの組み合わせを押さなければならない場合や、メディアから起動するようにシステムの BIOS (Basic Input/Output System) を設定しなければならない場合があります。詳細は、システムに同梱されているドキュメントをご覧ください。

- Red Hat Enterprise Linux ブート 画面が起動し、さまざまな起動オプションが表示されます。

キーボードの矢印キーを使用して起動オプションを選択し、Enter を押して、ブートオプションを選択します。Red Hat Enterprise Linux へようこそ 画面が開き、グラフィカルユーザーインターフェイスを使用して Red Hat Enterprise Linux をインストールできます。

注記起動画面で、60 秒以内に何も行わないと、インストールプログラムが自動的に開始します。

必要に応じて、利用可能な起動オプションを編集します。

- UEFI ベースのシステム:E を押して、編集モードにします。事前定義済みのコマンドラインを変更して、起動オプションを追加または削除します。Enter キーを押して、選択を確認します。

- BIOS ベースのシステム:キーボードの Tab キーを押して編集モードに入ります。事前定義済みのコマンドラインを変更して、起動オプションを追加または削除します。Enter キーを押して、選択を確認します。

3.1.7. PXE を使用してネットワークからインストールを起動

同時に多数のシステムに Red Hat Enterprise Linux をインストールする場合の最善のアプローチは、PXE サーバーから起動し、共有ネットワークにあるソースからインストールすることです。以下の手順に従って、PXE を使用してネットワークから Red Hat Enterprise Linux のインストールを起動します。

PXE を使用してネットワークからインストールプロセスを起動するには、イーサネットなどの物理ネットワーク接続を使用する必要があります。ワイヤレス接続でインストールプロセスを起動することはできません。

前提条件

- TFTP サーバーを設定しており、PXE に対応するシステムにネットワークインターフェイスがある。詳細は、関連情報 を参照してください。

- ネットワークインタフェースから起動するように、システムを設定している。このオプションは BIOS にあり、Network Boot または Boot Services のラベルが付けられる場合があります。

- 指定されたネットワークインターフェイスから BIOS が起動するように設定されており、PXE 標準をサポートしていることを確認した。詳細は、ハードウェアのドキュメントを参照してください。

手順

- ネットワークケーブルが接続されていることを確認します。コンピューターの電源スイッチが入っていない状態であっても、ネットワークソケットのリンク表示ライトは点灯しているはずです。

システムを切り替えます。

ハードウェアによっては、システムが PXE サーバーに接続する前に、ネットワーク設定と診断情報が表示されることがあります。接続すると、PXE サーバーの設定に応じたメニューが表示されます。

目的のオプションに対応する数字キーを押します。

注記場合によっては、起動オプションが表示されない場合があります。この場合は、キーボードの Enter キーを押します。起動画面が開くまで待ちます。

Red Hat Enterprise Linux ブート 画面が起動し、さまざまな起動オプションが表示されます。

キーボードの矢印キーを使用して起動オプションを選択し、Enter を押して、ブートオプションを選択します。Red Hat Enterprise Linux へようこそ 画面が開き、グラフィカルユーザーインターフェイスを使用して Red Hat Enterprise Linux をインストールできます。

注記起動画面で、60 秒以内に何も行わないと、インストールプログラムが自動的に開始します。

必要に応じて、利用可能な起動オプションを編集します。

- UEFI ベースのシステム:E を押して、編集モードにします。事前定義済みのコマンドラインを変更して、起動オプションを追加または削除します。Enter キーを押して、選択を確認します。

- BIOS ベースのシステム:キーボードの Tab キーを押して編集モードに入ります。事前定義済みのコマンドラインを変更して、起動オプションを追加または削除します。Enter キーを押して、選択を確認します。

関連情報

3.2. カスタマーポータルから ISO イメージを使用した RHEL のインストール

以下の手順に従って、カスタマーポータルからダウンロードした DVD ISO イメージを使用して RHEL をインストールします。この手順では、RHEL インストールプログラムを実行する方法を説明します。

DVD ISO イメージファイルを使用して GUI インストールを実行する場合は、Red Hat 機能への接続機能を使用してシステムを登録するまで、インストーラーの競合状態によりインストールが続行できなくなることがあります。詳細は、RHEL リリースノート の既知の問題に記載されている BZ#1823578 を参照してください。

前提条件

- カスタマーポータルから DVD ISO イメージファイルをダウンロードしている。詳細は、ベータインストールイメージのダウンロード を参照してください。

- 起動可能なインストールメディアを作成している。詳細は、起動可能な DVD または CD の作成 を参照してください。

- インストールプログラムを起動し、起動メニューが表示されている。詳細は、インストーラーの起動 を参照してください。

手順

- 起動メニューで Install Red Hat Enterprise Linux 8 を選択し、キーボードの Enter を押します。

- Welcome to Red Hat Enterprise Linux 8 画面で、言語およびロケーションを選択し、Continue をクリックします。Installation Summary 画面が開き、各設定のデフォルト値が表示されます。

- System > Installation Destination を選択し、Local Standard Disks ペーンでターゲットのディスクを選択してから Done をクリックします。ストレージ設定では、デフォルト設定が選択されます。

- システム > ネットワークとホスト名 を選択します。Network and Hostname 画面が開きます。

- Network and Hostname 画面で、 Ethernet を ON に切り替えて、Done をクリックします。インストーラーは利用可能なネットワークに接続し、そのネットワークで利用可能なデバイスを設定します。必要に応じて、利用可能なネットワークリストから、任意のネットワークを選択して、そのネットワークで利用可能なデバイスを設定できます。

- ユーザー設定 > root パスワード を選択します。root パスワード 画面が開きます。

- Root Password 画面で、root アカウントに設定するパスワードを入力し、Done をクリックします。インストールプロセスを完了し、システム管理者ユーザーアカウントにログインするには、root パスワードが必要です。

- オプション:User Settings > User Creation を選択して、ユーザーアカウントを作成してインストールプロセスを完了します。root アカウントの代わりに、このユーザーアカウントを使用して、システム管理タスクを実行できます。

Create User 画面で以下を実行し、Done をクリックします。

- 作成するアカウントの名前とユーザー名を入力します。

- Make this user administrator と Require a password to use this account を選択します。インストールプログラムは、このユーザーを wheel グループに追加し、デフォルト設定でパスワード保護されたユーザーアカウントを作成します。パスワードで保護された管理ユーザーアカウントを作成することを推奨します。

- Begin Installation をクリックしてインストールを開始し、インストールが完了するまで待ちます。これには数分かかる場合があります。

- インストールプロセスが完了したら、再起動 をクリックして、システムを再起動します。

起動時にインストールメディアが自動的に取り出せない場合は、忘れずに取り出してください。

Red Hat Enterprise Linux 8 は、通常のシステム起動シーケンスが完了すると起動します。X Window System でワークステーションにシステムをインストールしている場合は、システムを設定するアプリケーションが起動します。このアプリケーションを使用すると初期設定が可能になり、システムの時刻と日付の設定、Red Hat へのマシンの登録などが行えます。X Window System がインストールされていない場合は、

login:プロンプトが表示されます。注記UEFI セキュアブートが有効になっているシステムに、Red Hat Enterprise Linux ベータ版リリースをインストールした場合は、システムの Machine Owner Key (MOK) リストにベータ版の公開鍵を追加します。

- 初期セットアップ 画面で、ライセンスアグリーメントに同意して、システムを登録します。

3.3. GUI で CDN から RHEL の登録およびインストール

このセクションでは、GUI を使用して、システムを登録し、RHEL サブスクリプションを割り当て、Red Hat コンテンツ配信ネットワーク (CDN) から RHEL をインストールする方法を説明します。

3.3.1. コンテンツ配信ネットワークとは

cdn.redhat.com で利用できる Red Hat コンテンツ配信ネットワーク (CDN) は、地理的に分散している一連の静的な Web サーバーです。これには、システムが使用するコンテンツとエラータが含まれます。コンテンツは、Red Hat Subscription Management に登録されたシステムを使用するなどして、直接使用できます。CDN は x.509 証明書認証で保護され、有効なユーザーのみがアクセスできるようにします。システムが Red Hat Subscription Management に登録されると、割り当てたサブスクリプションにより、システムがアクセスできる CDN のサブセットが管理されます。

CDN から RHEL を登録してインストールすると、以下の利点があります。

- CDN のインストール方法は、Boot ISO および DVD ISO のイメージファイルに対応します。ただし、大きな DVD ISO イメージファイルよりも領域が少ないため、小さい Boot ISO イメージファイルを使用することが推奨されます。

- CDN は最新のパッケージを使用するため、インストール直後は完全に最新のシステムになります。DVD ISO イメージファイルを使用する場合によくあるように、インストール直後にすぐにパッケージの更新をインストールする必要はありません。

- Red Hat Insights への接続、およびシステムの目的の有効化に対するサポートが統合されました。

CDN から RHEL を登録してインストールする方法は、GUI およびキックスタートで対応しています。GUI を使用して RHEL を登録してインストールする方法は、標準的な RHEL 8 インストールの実行 を参照してください。キックスタートを使用して RHEL を登録してインストールする方法は、高度な RHEL 8 インストールの実行 を参照してください。

3.3.2. CDN から RHEL の登録およびインストール

この手順に従って、GUI で、システムを登録し、RHEL サブスクリプションを割り当て、Red Hat コンテンツ配信ネットワーク (CDN) から RHEL をインストールします。

CDN 機能は、Boot ISO および DVD ISO のイメージファイルでサポートされています。ただし、Boot ISO イメージファイルのインストールソースのデフォルトは CDN であるため、Boot ISO イメージファイルを使用することが推奨されます。

前提条件

- CDN にアクセスできるネットワークに接続されている。

- カスタマーポータルから Boot ISO イメージファイルをダウンロードしている。

- 起動可能なインストールメディアを作成している。

- インストールプログラムを起動し、起動メニューが表示されている。システム登録後に使用されるインストールリポジトリーは、システムの起動方法により異なる点に注意してください。

手順

- 起動メニューで Install Red Hat Enterprise Linux 8 を選択し、キーボードの Enter を押します。

- Welcome to Red Hat Enterprise Linux 8 画面で、言語およびロケーションを選択し、Continue をクリックします。Installation Summary 画面が開き、各設定のデフォルト値が表示されます。

- System > Installation Destination を選択し、Local Standard Disks ペーンでターゲットのディスクを選択してから Done をクリックします。ストレージ設定では、デフォルト設定が選択されます。ストレージ設定のカスタマイズの詳細は、ソフトウェア設定の定義、ストレージデバイス、手動パーティション設定 を参照してください。

- システム > ネットワークとホスト名 を選択します。Network and Hostname 画面が開きます。

- Network and Hostname 画面で、 Ethernet を ON に切り替えて、Done をクリックします。インストーラーは利用可能なネットワークに接続し、そのネットワークで利用可能なデバイスを設定します。必要に応じて、利用可能なネットワークリストから、任意のネットワークを選択して、そのネットワークで利用可能なデバイスを設定できます。ネットワークまたはネットワークデバイスの設定に関する詳細は、ネットワークホスト名 を参照してください。

- Software > Connect to Red Hat を選択します。Connect to Red Hat ウィンドウが開きます。

Connect to Red Hat ウィンドウで以下の手順を実行します。

Authentication の方法を選択し、選択した方法をもとに詳細を指定します。

アカウント 認証方式の場合: Red Hat カスタマーポータルのユーザー名およびパスワードの詳細を入力します。

アクティベーションキー 認証方式の場合: 組織 ID およびアクティベーションキーを入力します。サブスクリプションにアクティベーションキーが登録されている限り、複数のアクティベーションキーをコンマで区切って入力できます。

Set System Purpose チェックボックスを選択し、該当するドロップダウンリストから必要な Role、SLA、Usage を選択します。

システムの目的を使用して、Red Hat Enterprise Linux 8 システムの使用目的を記録し、エンタイトルメントサーバーがシステムに最も適したサブスクリプションを自動的に割り当てていることを確認します。

Red Hat Insights への接続 チェックボックスはデフォルトで有効になっています。Red Hat Insights に接続する必要がない場合には、チェックボックスの選択を解除します。

Red Hat Insights は SaaS (Software-as-a-Service) 製品で、継続的に、登録済みの Red Hat ベースのシステムに詳細な分析を提供し、物理環境、仮想環境、クラウド環境、およびコンテナーデプロイメントでセキュリティー、パフォーマンス、および安定性に関する脅威をプロアクティブに特定します。

必要に応じて、オプション をデプロイメントし、ネットワーク通信タイプを選択します。

- ネットワーク環境で、外部のインターネットアクセスのみ、または HTTP プロキシーを介したコンテンツサーバーへのアクセスが許可されている場合は、HTTP プロキシーの使用 チェックボックスを選択します。

Register をクリックします。システムが正常に登録され、サブスクリプションが割り当てられると、Red Hat への接続 ウィンドウに、割り当てられているサブスクリプションの詳細が表示されます。

サブスクリプションのサイズによっては、登録および割り当てのプロセスが完了するのに最大 1 分かかることがあります。

完了 をクリックします。

Red Hat への接続 の下に 登録 メッセージが表示されます。

- ユーザー設定 > root パスワード を選択します。root パスワード 画面が開きます。

Root Password 画面で、root アカウントに設定するパスワードを入力し、Done をクリックします。インストールプロセスを完了し、システム管理者ユーザーアカウントにログインするには、root パスワードが必要です。

パスワード作成の要件および推奨事項の詳細は、root パスワードの設定 を参照してください。

- オプション:User Settings > User Creation を選択して、ユーザーアカウントを作成してインストールプロセスを完了します。root アカウントの代わりに、このユーザーアカウントを使用して、システム管理タスクを実行できます。

- Create User 画面で以下を実行し、Done をクリックします。

- 作成するアカウントの名前とユーザー名を入力します。

Make this user administrator と Require a password to use this account を選択します。インストールプログラムは、このユーザーを wheel グループに追加し、デフォルト設定でパスワード保護されたユーザーアカウントを作成します。パスワードで保護された管理ユーザーアカウントを作成することを推奨します。

ユーザーアカウントのデフォルト設定を編集する方法は、ユーザーアカウントの作成 を参照してください。

- Begin Installation をクリックしてインストールを開始し、インストールが完了するまで待ちます。これには数分かかる場合があります。

- インストールプロセスが完了したら、再起動 をクリックして、システムを再起動します。

起動時にインストールメディアが自動的に取り出せない場合は、忘れずに取り出してください。

Red Hat Enterprise Linux 8 は、通常のシステム起動シーケンスが完了すると起動します。X Window System でワークステーションにシステムをインストールしている場合は、システムを設定するアプリケーションが起動します。このアプリケーションを使用すると初期設定が可能になり、システムの時刻と日付の設定、Red Hat へのマシンの登録などが行えます。X Window System がインストールされていない場合は、

login:プロンプトが表示されます。注記UEFI セキュアブートが有効になっているシステムに、Red Hat Enterprise Linux ベータ版リリースをインストールした場合は、システムの Machine Owner Key (MOK) リストにベータ版の公開鍵を追加します。

- 初期セットアップ 画面で、ライセンスアグリーメントに同意して、システムを登録します。

関連情報

- ネットワークのカスタマイズ方法、Red Hat への接続、システムの目的、インストール先、KDUMP、およびセキュリティーポリシーをカスタマイズする方法

- Red Hat Insights product documentation

- Understanding Activation Keys

-

Subscription Manager の HTTP プロキシーの設定は、

subscription-managerman ページのPROXY CONFIGURATIONセクションを参照してください。

3.3.2.1. システム登録後のインストールソースリポジトリー

システム登録後に使用されるインストールソースリポジトリーは、システムの起動方法により異なります。

- Boot ISO または DVD ISO のイメージファイルから起動するシステム

-

Boot ISOまたはDVD ISOのいずれかのイメージファイルを使用して、デフォルトの起動パラメーターを使用して RHEL インストールを起動した場合、インストールプログラムは、登録後にインストールソースリポジトリーを CDN に自動的に切り替えます。 inst.repo=<URL>ブートパラメーターで起動したシステム-

起動パラメーター

inst.repo=<URL>を使用して RHEL インストールを起動すると、インストールプログラムは、登録後に自動的にインストールソースリポジトリーを CDN に切り替えません。CDN を使用して RHEL をインストールする場合は、グラフィカルインストールの インストールソース 画面で Red Hat CDN オプションを選択し、インストールソースリポジトリーを CDN に手動で切り替える必要があります。CDN に手動で切り替えないと、インストールプログラムは、カーネルコマンドラインで指定されたリポジトリーからパッケージをインストールします。

-

キックスタートコマンドの

rhsmを使用してインストールソースリポジトリーを CDN に切り替えることができるのは、カーネルコマンドラインのinst.repo=またはキックスタートファイルのurlコマンドを使用してインストールソースを指定しない場合に限定されます。インストールイメージを取得するには、カーネルコマンドラインでinst.stage2=<URL>を使用する必要がありますが、インストールソースは指定しないでください。 -

起動オプションを使用して指定したインストールソース URL、またはキックスタートファイルに含まれるインストールソース URL は、キックスタートファイルに有効な認証情報を持つ

rhsmコマンドが含まれている場合でも CDN よりも優先されます。システムが登録されていますが、URL インストールソースからインストールされています。これにより、以前のインストールプロセスが通常通りに動作するようになります。

3.3.3. CDN からシステム登録の確認

以下の手順に従って、GUI で、システムが CDN に登録されていることを確認します。

インストール概要 画面から インストールの開始 ボタンを クリックしていない 場合に限り、CDN から登録を確認できます。インストールの開始 ボタンをクリックしたら、インストール概要画面に戻って登録を確認することができなくなります。

前提条件

- GUI を使用した CDN からの登録およびインストール に従って登録プロセスを完了し、インストール概要 画面の Red Hat への接続 の下に 登録済 と表示されている。

手順

- インストール概要 画面で、Red Hat への接続 を選択します。

ウィンドウが開き、登録の概要が表示されます。

- 方法

- 登録済みアカウント名またはアクティベーションキーが表示されます。

- システムの目的

- 設定されていると、ロール、SLA、使用方法の詳細が表示されます。

- Insights

- 有効にすると、Insights の詳細が表示されます。

- サブスクリプションの数

- 割り当てたサブスクリプションの数が表示されます。注記:シンプルコンテンツアクセスモードでは、サブスクリプションがリスト表示されないのは有効な動作です。

- 登録概要が、入力した詳細と一致していることを確認します。

3.3.4. CDN からシステムの登録解除

以下の手順に従って、GUI で CDN からシステムの登録を解除します。

- インストール概要 画面から インストールの開始 ボタンを クリックしていない 場合は、CDN から登録を解除できます。インストールの開始 ボタンをクリックしたら、インストール概要画面に戻って登録を解除することができなくなります。

登録を解除すると、インストールプログラムは、利用可能な最初のリポジトリーに以下の順序で切り替えます。

- カーネルコマンドラインの inst.repo=<URL> 起動パラメーターで使用される URL

- インストールメディア (USB または DVD) で自動的に検出されるリポジトリー

前提条件

- CDN から RHEL の登録およびインストール に従って登録プロセスを完了し、インストール概要 画面の Red Hat への接続 の下に 登録済 と表示されている。

手順

- インストール概要 画面で、Red Hat への接続 を選択します。

Red Hat への接続 画面が開き、登録の概要が表示されます。

- 方法

- 使用される登録アカウント名またはアクティベーションキーが表示されます。

- システムの目的

- 設定されていると、ロール、SLA、使用方法の詳細が表示されます。

- Insights

- 有効にすると、Insights の詳細が表示されます。

- サブスクリプションの数

- 割り当てたサブスクリプションの数が表示されます。注記:シンプルコンテンツアクセスモードでは、サブスクリプションがリスト表示されないのは有効な動作です。

- 登録解除 をクリックして、CDN から登録を削除します。元の登録情報が表示され、画面の中央下部に 未登録 メッセージが表示されます。

- 完了 をクリックして、インストール概要 画面に戻ります。

- Red Hat への接続 に 未登録 メッセージが表示され、ソフトウェアの選択 には Red Hat CDN では登録が必要です メッセージが表示されます。

システムの登録を解除したら、システムを再登録できます。Red Hat への接続 をクリックします。以前入力した詳細が入力されます。元の詳細情報を編集するか、アカウント、目的、および接続に基づいてフィールドを更新します。登録 をクリックして終了します。

3.4. インストールの完了

インストールが完了するまで待ちます。これには数分の時間がかかる場合があります。

インストールが完了したら、再起動時にインストールメディアが自動的に取り出されない場合は削除します。

Red Hat Enterprise Linux 8 は、通常のシステム起動シーケンスが完了すると起動します。X Window System でワークステーションにシステムをインストールしている場合は、システムを設定するアプリケーションが起動します。このアプリケーションを使用すると初期設定が可能になり、システムの時刻と日付の設定、Red Hat へのマシンの登録などが行えます。X Window System がインストールされていない場合は、login: プロンプトが表示されます。

システムの初期セットアップ、登録、および保護を完了する方法については、標準の RHEL 8 インストールの実行 ドキュメントの インストール後のタスクの完了 セクションを参照してください。

第4章 インストールのカスタマイズ

Red Hat Enterprise Linux をインストールする場合は、インストール概要 画面を使用して、場所、ソフトウェア、およびシステム設定およびパラメーターをカスタマイズできます。

インストール概要 画面には、以下のカテゴリーが含まれます。

- 多言語化

- キーボード、言語サポート、および時間と日付を設定できます。

- ソフトウェア

- Red Hat への接続、インストールソース、およびソフトウェアの選択を設定できます。

- システム

- インストール先、KDUMP、ネットワークおよびホスト名、セキュリティーポリシーを設定できます。

- ユーザー設定

- システム管理タスクに使用する管理者アカウントにログインし、システムにログインするユーザーアカウントを作成するように root パスワードを設定できます。

カテゴリーは、インストールプログラムのどこにあるかによって、ステータスが異なります。

表4.1 カテゴリーのステータス

| 状態 | 説明 |

|---|---|

| 感嘆符と赤いテキストが付いた黄色の三角形 | インストールする前に注意が必要です。たとえば、コンテンツ配信ネットワーク (CDN) から登録してダウンロードする前に、ネットワークおよびホスト名を確認する必要があります。 |

| 灰色で警告マークが付いたもの (感嘆符付きの黄色の三角形) | インストールプログラムがカテゴリーを設定しているため、カテゴリーが終了しないとその画面にアクセスできません。 |

インストール概要 画面の下部には警告メッセージが表示され、インストールの開始 ボタンは、必要なカテゴリーがすべて設定されるまで無効になっています。

このセクションは、グラフィカルユーザーインターフェイス (GUI) を使用した Red Hat Enterprise Linux インストールのカスタマイズを説明します。GUI は、CD、DVD、または USB フラッシュドライブから、もしくは PXE を使用してネットワークからシステムを起動する場合に、Red Hat Enterprise Linux をインストールするのに推奨される方法です。

オンラインヘルプと、カスタマーポータルで公開している内容に矛盾がある可能性もあります。最新の更新は、カスタマーポータルのインストールコンテンツを参照してください。

4.1. 言語およびロケーションの設定

インストールプログラムは、インストール時に選択した言語を使用します。

前提条件

- インストールメディアを作成している。詳細は、起動可能な DVD または CD の作成 を参照してください。

- Boot ISO イメージファイルを使用してインストールソースを指定している。詳細は、インストールソースの準備 を参照してください。

- インストールを起動している。詳細は、インストーラーの起動 を参照してください。

手順

Welcome to Red Hat Enterprise Linux 画面の左側のペインで、言語を選択します。または、検索 フィールドに、希望の言語を入力します。

注記言語は、デフォルトで設定されています。ネットワークアクセスが設定されている、つまりローカルメディアではなくネットワークサーバーからシステムを起動した場合、事前選択の言語は、GeoIP モジュールの位置自動検出機能により決定します。起動コマンドライン、または PXE サーバー設定で

inst.lang=オプションを使用した場合は、起動オプションで定義した言語が選択されます。- Red Hat Enterprise Linux へようこそ 画面の右側のペインから、お住まいの地域に合ったロケーションを選択してください。

- Continue をクリックして、グラフィカルインストール 画面に進みます。

Red Hat Enterprise Linux のプレリリース版をインストールしようとしている場合は、インストールメディアのプレリリースステータスに関する警告メッセージが表示されます。

- インストールを続行するには、I want to proceed をクリックします。あるいは、

- インストールを終了してシステムを再起動するには、I want to exit をクリックします。

関連情報

4.2. ローカライゼーションオプションの設定

このセクションでは、キーボード、言語サポート、および日時設定を行う方法を説明します。

ロシア語 のようにラテン文字を受け付けないレイアウトを使用する場合は、一緒に 英語 (US) レイアウトも追加して、2 つのレイアウトを切り替えられるようにキーボードを設定します。ラテン文字を含まないレイアウトを選択すると、この後のインストールプロセスで有効な root パスワードおよびユーザー認証情報を入力できない場合があります。これにより、インストールを完了できない可能性があります。

キーボード、言語、および日時の設定は、デフォルトで Anaconda を使用した RHEL のインストール で行います。設定を変更する場合は次の手順を実行します。変更しない場合は ソフトウェア設定の定義 に進みます。

手順

キーボード設定を定義します。

- インストール概要 画面で キーボード をクリックします。デフォルトのレイアウトは、Anaconda を使用した RHEL のインストール で選択したオプションによって異なります。

- + をクリックして キーボードレイアウトを追加 画面を開き、別のレイアウトに変更します。

- リストを参照してレイアウトを選択するか、検索 フィールドを使用します。

- 必要なレイアウトを選択して、追加 をクリックします。デフォルトレイアウトの下に新しいレイアウトが表示されます。

- 必要に応じて オプション をクリックして、使用可能なレイアウトを切り替えるキーボードスイッチを設定します。レイアウト切り替えのオプション 画面が開きます。

切り替え用のキーの組み合わせを設定するには、1 つ以上のキーの組み合わせを選択し、OK をクリックして選択を確定します。

注記レイアウトを選択して キーボード ボタンをクリックすると、選択したレイアウトの視覚的表現を表示する新しいダイアログボックスが開きます。

- Done をクリックして設定を適用し、グラフィカルインストール に戻ります。

言語設定を定義します。

- インストール概要 画面で 言語サポート をクリックします。言語サポート 画面が開きます。左側のペインには、利用可能な言語グループのリストが表示されます。グループの中から 1 つ以上の言語を設定すると、チェックマークが表示され、対応する言語が強調表示されます。

- 左側のペインからグループをクリックして追加の言語を選択し、右側のペインから地域のオプションを選択します。必要なすべての言語に対してこの手順を繰り返します。

- Done をクリックして変更を適用し、グラフィカルインストール に戻ります。

日時設定を定義します。

インストール概要 画面から、日付と時刻 をクリックします。日付と時刻 画面が開きます。

注記日付と時刻 で選択した設定に基づいて、Anaconda を使用した RHEL のインストール の設定がデフォルトで設定されます。

表示される都市や地域のリストは、タイムゾーンデータベース (

tzdata) のパブリックドメインのものが使用されています。このドメインは IANA (Internet Assigned Numbers Authority) で管理されています。Red Hat がこのデータベースに都市や地域を追加することはできません。詳細は、IANA 公式の Web サイト をご覧ください。地域 ドロップダウンメニューから、地域を選択します。

注記ロケーションを特定の地域に設定せずに、グリニッジ標準時 (GMT) を基準にしたタイムゾーンを設定する場合は、お住まいの地域に Etc を選択できます。

- 都市 ドロップダウンメニューから都市、もしくは同じタイムゾーン内でお住まいの場所に最も近い都市を選択します。

ネットワーク時刻 スイッチを切り替え、ネットワークタイムプロトコル (NTP) を使用して、ネットワーク時刻同期を有効または無効にします。

注記ネットワークスイッチを有効にし、システムにインターネットへのアクセスがあれば、システムの時刻が正確に保たれます。デフォルトでは、NTP プールが 1 つ設定されています。新しいオプションを追加するか、ネットワーク時刻 スイッチの横にある 歯車のボタン をクリックして、デフォルトのオプションを無効にするか削除します。

Done をクリックして変更を適用し、グラフィカルインストール に戻ります。

注記ネットワークの時刻同期を無効にすると、画面下部のコントロールがアクティブになり、手動で時刻と日付を設定できます。

4.3. システムオプションの設定

この接続は、インストール先、KDUMP、ネットワークおよびホスト名、ならびにセキュリティーポリシーを設定する方法を説明します。

4.3.1. インストール先の設定

インストール先 画面では、Red Hat Enterprise Linux のインストール先として使用するディスクなどのストレージオプションを設定します。ディスクは、1 つ以上選択する必要があります。

今後、データが含まれているディスクを使用する予定がある場合は、データをバックアップします。たとえば、既存の Microsoft Windows パーティションを縮小し、Red Hat Enterprise Linux を 2 つ目のシステムとしてインストールする場合、または以前のリリースの Red Hat Enterprise Linux をアップグレードする場合です。パーティションの操作は常にリスクが伴います。たとえば、何らかの理由でプロセスが中断または失敗した場合は、ディスクのデータが失われる可能性があります。

特殊なケース

-

BIOS によっては、RAID カードからの起動に対応していないため注意が必要です。このとき、別のハードドライブなど、RAID アレイ以外のパーティションに

/bootパーティションを作成する必要があります。そのような RAID カードへのパーティション作成には、内蔵ハードドライブを使用する必要があります。また、/bootパーティションは、ソフトウェア RAID の設定にも必要です。システムのパーティション設定を自動で選択した場合は、/bootパーティションを手動で修正する必要があります。 - Red Hat Enterprise Linux ブートローダーが、別のブートローダーから チェーンロード するように設定するには、インストール先 画面で 完全なディスク要約とブートローダー をクリックして、手動でブートドライブを指定する必要があります。

- マルチパスのストレージデバイスと、非マルチパスのストレージデバイスの両方が使用されているシステムに Red Hat Enterprise Linux をインストールすると、インストールプログラムによる自動パーティション設定のレイアウトに、マルチパスのデバイスと非マルチパスのデバイスが混在したボリュームグループが作成されます。これはマルチパスストレージの目的に反することになります。インストール先 画面では、マルチパスのみ、または非マルチパスのみのいずれかを選択することが推奨されます。もしくは、手動のパーティション設定を実行してください。

前提条件

インストール概要 画面が開いている。

手順

インストール概要 画面から、インストール先 をクリックします。インストール先 画面が開きます。

ローカルの標準ディスク セクションから、必要なストレージデバイスを選択します。選択したストレージデバイスには白いチェックマークが表示されます。白いチェックマークが付いていないディスクはインストール時には使用されません。自動パーティショニングを選択した場合は無視され、手動パーティショニングでは使用できません。

注記ローカルで利用可能なすべてのストレージデバイス (SATA、IDE、SCSI ハードドライブ、USB フラッシュ、および外部ディスク) は、ローカルの標準ディスク に表示されます。インストールプログラムの起動後に接続したストレージデバイスは検出されません。リムーバブルドライブを使用して Red Hat Enterprise Linux をインストールする場合は、デバイスを削除するとシステムが使用できなくなります。

オプション:画面右下の 更新 リンクをクリックして、新しいハードドライブに接続するローカルストレージデバイスを設定します。ディスクの再スキャン ダイアログボックスが開きます。

注記インストール時に行ったストレージへの変更は、ディスクの再スキャン をクリックするとすべて失われます。

- ディスクの再スキャン をクリックし、スキャン処理が完了するまで待ちます。

- OK をクリックして、インストール先 画面に戻ります。検出したディスク (新しいディスクを含む) はすべて、ローカルの標準ディスク セクションに表示されます。

オプション:専用のストレージデバイスを追加するには、ディスクの追加...

ストレージデバイスの選択 画面が開き、インストールプログラムがアクセスするストレージデバイスのリストを表示します。

オプション:ストレージの設定 から 自動 ラジオボタンを選択します。

重要自動パーティション分割は、ストレージをパーティション分割するのに 推奨される 方法です。

パーティション設定はカスタマイズできます。詳細は、手動パーティションの設定 を参照してください。

- オプション:既存のパーティションレイアウトから領域を確保するには、利用可能な領域を追加する チェックボックスを選択します。たとえば、使用するディスクにオペレーティングシステムが含まれ、このシステムのパーティションを小さくして、Red Hat Enterprise Linux 用の領域を広くした場合などです。

オプション:データの暗号化 を選択し、Linux Unified Key Setup (LUKS) を使用して、(

/bootなどの) システムを起動する必要があるパーティションを除いた、すべてのパーティションを暗号化します。ハードドライブの暗号化が推奨されます。完了 をクリックします。ディスク暗号化パスフレーズ ダイアログボックスが開きます。

- パスフレーズ フィールドおよび 確認 フィールドに、パスフレーズを入力します。

パスフレーズの保存 をクリックして、ディスクの暗号化を完了します。

警告LUKS パスフレーズが分からなくなると、暗号化されたパーティションと、その上にあるデータには完全にアクセスできなくなります。分からなくなったパスフレーズを復元する方法はありません。ただし、キックスタートインストールを実行した場合は、インストール中に暗号パスフレーズを保存し、バックアップ用に暗号化パスフレーズを作成できます。詳細は、高度な RHEL 8 インストールの実行 を参照してください。

オプション: 画面左下の 完全なディスク要約とブートローダー をクリックして、ブートローダーを追加するストレージデバイスを選択します。

詳細は ブートローダーのインストール を参照してください。

注記大概は、ブートローダーをデフォルトの場所に置いておくだけで十分です。たとえば、他のブートローダーからのチェーンロードを必要とするシステムなど、一部の設定ではブートドライブを手動で指定する必要があります。

完了 をクリックします。

自動パーティショニング と 利用可能な領域を追加する を選択した場合、または、Red Hat Enterprise Linux のインストールに選択したハードドライブの空き領域が十分ではない場合は、ディスク領域の再利用 ダイアログボックスを開いて 完了 をクリックすると、そのデバイスに設定したディスクデバイスとパーティションのリストが表示されます。ダイアログボックスは、システムで最小インストールに必要な領域に関する情報と、確保した領域のサイズに関する情報が表示されます。

警告パーティションを 削除 すると、そのパーティションのデータはすべて失われます。データを保存したい場合は、削除 オプションではなく、縮小 オプションを使用してください。

- 表示された、利用可能なストレージデバイスのリストを確認します。再利用可能な領域 列には、各エントリーから再利用できる領域のサイズが表示されます。

領域を確保し、ディスクまたはパーティションを選択してから 削除 ボタンをクリックしてそのパーティションを削除するか、選択したディスクにあるすべてのパーティションを削除します。もしくは 縮小 ボタンを押して、既存データを維持しながらパーティションの空き領域を使用します。

注記または、すべて削除 をクリックすると、すべてのディスクに存在するすべてのパーティションが削除されるため、Red Hat Enterprise Linux 8 でこの領域を利用できるようになります。すべてのディスクにあるデータはすべて失われます。

- Reclaim space をクリックして変更を適用し、グラフィカルインストール に戻ります。

インストール概要 画面で インストールの開始 をクリックするまで、ディスクへの変更は行われません。再利用 ダイアログボックスは、パーティションをサイズ変更や削除の対象としてマークするだけで、そのアクションはすぐには実行されません。

4.3.2. ブートローダーの設定

Red Hat Enterprise Linux は、GRand Unified Bootloader バージョン 2 (GRUB2) を、AMD64、Intel 64、IBM Power Systems、および ARM として使用します。64 ビットの IBM Z では、zipl ブートローダーが使用されます。

ブートローダーは、システムの起動時に実行し、制御をオペレーティングシステムに読み込み、転送する最初のプログラムです。GRUB2 は、互換性のあるオペレーティングシステム (Microsoft Windows を含む) であれば起動可能で、チェーンロードを使用すれば、未対応のオペレーティングシステムのブートローダーにも読み込んだ指示を渡すことができます。

GRUB2 をインストールすると、既存のブートローダーを上書きできます。

オペレーティングシステムがすでにインストールされていると、Red Hat Enterprise Linux インストールプログラムはそのブートローダーを自動的に検出して、別のオペレーティングシステムを起動するように設定します。そのブートローダーが正しく検出されない場合は、インストールの完了後に、追加のオペレーティングシステムを手動で設定できます。

複数のディスクを搭載した Red Hat Enterprise Linux システムをインストールする場合は、ブートローダーをインストールするディスクを手動で指定することを推奨します。

手順

インストール先 画面で 完全なディスク要約とブートローダー をクリックします。選択したディスク ダイアログボックスが開きます。

ブートローダーは、選択したデバイス、または UEFI システムにインストールされます。ガイド付きパーティションの作成時に、そのデバイスに EFI システムパーティション が作成されます。

- 起動デバイスを変更するには、リストからデバイスを選択して ブートデバイスとして設定 をクリックします。起動デバイスとして設定できるデバイスは 1 つだけです。

- 新しいブートローダーのインストールを無効にする場合は、現在起動用として設定されているデバイスを選択し、ブートローダーをインストールしない をクリックします。これにより、いずれのデバイスにも GRUB2 がインストールされないようになります。

ブートローダーをインストールしないを選択した場合は、システムを直接起動できなくなるため、別の起動方法 (市販のスタンドアロンのブートローダーアプリケーションなど) を使用しなければならなくなります。ブートローダーをインストールしないは、システムを起動させる方法が別に確保されている場合に限定してください。

ブートローダーは、システムが BIOS または UEFI のファームウェアを使用しているか、ブートドライブに GUID Partition Table (GPT) または Master Boot Record (MBR) (msdos としても知られている) があるかどうかによって、特別なパーティションを作成する必要があります。自動パーティション作成を使用していると、インストールプログラムがパーティションを作成します。

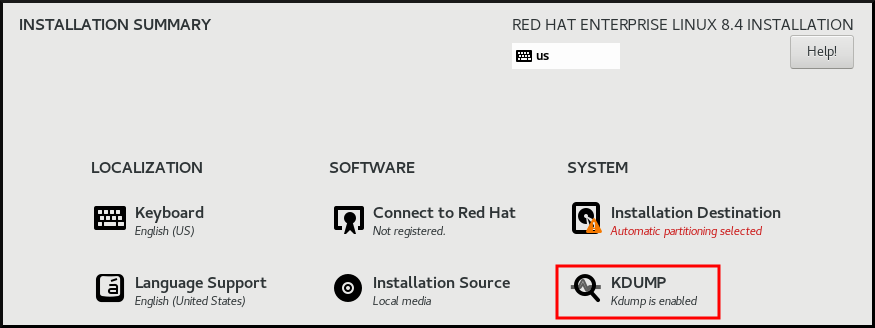

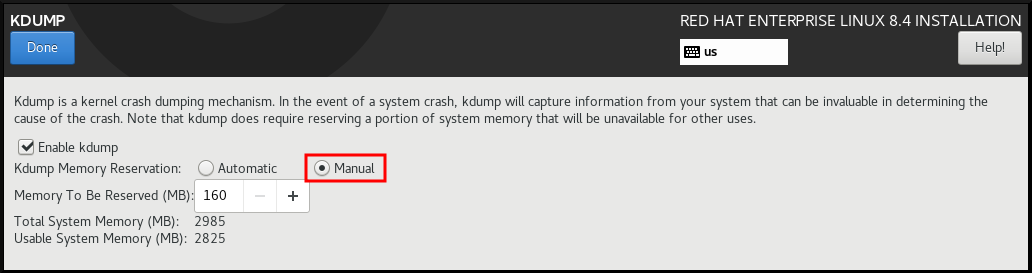

4.3.3. Kdump の設定

Kdump は、カーネルのクラッシュダンプメカニズムです。システムがクラッシュすると、Kdump が、障害発生時のシステムメモリーの内容をキャプチャーします。キャプチャーしたメモリーを解析すると、クラッシュの原因を見つけることができます。Kdump が有効になっている場合は、システムメモリー (RAM) のごく一部をそれ自身に予約する必要があります。予約したメモリーは、メインのカーネルにアクセスできません。

手順

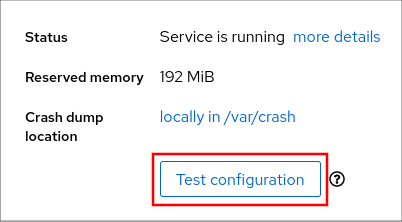

- インストール概要 画面から、Kdump をクリックします。Kdump 画面が開きます。

- kdump を有効にする チェックボックスを選択します。

メモリー予約設定を、自動 または 手動 のいずれかから選択します。

- 手動 を選択し、+ ボタンおよび - ボタンを使用して、予約されるメモリー フィールドに、予約するメモリー量 (メガバイト) を入力します。予約入力フィールドの下にある 使用可能なシステムメモリー には、選択したサイズの RAM を予約してから、メインシステムにアクセスできるメモリーの量が示されます。

- Done をクリックして設定を適用し、グラフィカルインストール に戻ります。

予約するメモリーの量は、システムのアーキテクチャー (AMD64 と Intel 64 の要件は IBM Power とは異なります) と、システムメモリーの総量により決まります。ほとんどの場合は、自動予約で十分です。

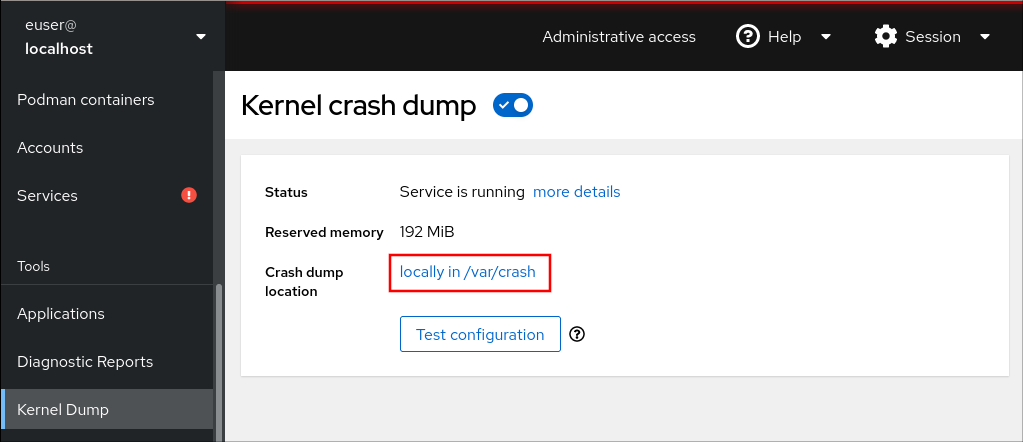

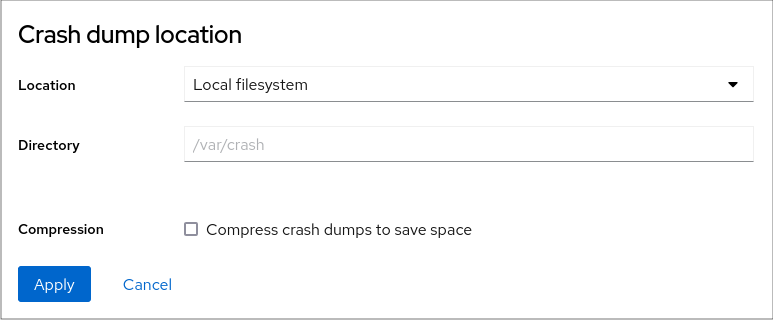

カーネルクラッシュダンプの保存場所などの追加設定は、インストール後に system-config-kdump グラフィカルインターフェイスで設定するか、/etc/kdump.conf 設定ファイルに手動で設定できます。

4.3.4. ネットワークおよびホスト名のオプションの設定

ネットワークとホスト名 画面は、ネットワークインターフェイスを設定するために使用されます。ここで選択したオプションは、インストール済みシステムだけでなく、インストール時にリモートからパッケージをダウンロードするなどのタスクを行う際にも利用できます。

以下の手順に従って、ネットワークとホスト名を設定します。

手順

- インストール概要 画面から、ネットワークとホスト名 をクリックします。

左側のペインのリストから、インターフェイスを選択します。詳細が右側のペインに表示されます。

注記-

em1やwl3sp0といった一貫性のある名前をネットワークデバイスの特定に使用するネットワークデバイス命名の標準仕様には、いくつかのタイプがあります。このような標準仕様の詳細は Configuring and managing networking を参照してください。

-

選択したインタフェースを有効または無効にするには、ON/OFF スイッチを切り替えます。

注記インストールプログラムは、ローカルでアクセス可能なインターフェイスを自動的に検出し、手動で追加または削除できません。

- + をクリックして、仮想ネットワークインターフェイスを追加します。仮想ネットワークインターフェイスは、チーム、ボンド、ブリッジ、または VLAN のいずれかです。

- - を選択して、仮想インターフェイスを削除します。

- 設定 をクリックして、既存のインターフェイスの IP アドレス、DNS サーバー、またはルーティング設定 (仮想と物理の両方) などの設定を変更します。

ホスト名 フィールドに、システムのホスト名を入力します。

注記-

ホスト名は、

hostname.domainname形式の完全修飾ドメイン名 (FQDN)、またはドメインなしの短縮ホスト名のいずれかにします。多くのネットワークには、自動的に接続したシステムにドメイン名を提供する DHCP (Dynamic Host Configuration Protocol) サービスがあります。DHCP サービスがこのシステムにドメイン名を割り当てるようにするには、短縮ホスト名のみを指定します。 -

静的 IP およびホスト名の設定を使用する場合、短縮名または FQDN を使用するかどうかは、計画したシステムのユースケースによって異なります。Red Hat Identity Management はプロビジョニング時に FQDN を設定しますが、サードパーティーのソフトウェア製品によっては短縮名が必要になる場合があります。いずれの場合も、すべての状況で両方のフォームの可用性を確保するには、

IP FQDN short-aliasの形式で/etc/hosts'にホストのエントリーを追加します。 -

localhostの値は、ターゲットシステムの静的ホスト名が指定されておらず、(たとえば、DHCP または DNS を使用する NetworkManager による) ネットワーク設定時に、インストールされるシステムの実際のホスト名が設定されることを示しています。 -

ホスト名に使用できるのは、英数字と

-または.のみです。ホスト名は 64 文字以下である必要があります。ホスト名は、-および.で開始したり終了したりできません。DNS に準拠するには、FQDN の各部分は 63 文字以下で、ドットを含む FQDN の合計の長さは 255 文字を超えることができません。

-

ホスト名は、

- Apply をクリックして、ホスト名をインストーラー環境に適用します。

- また、ネットワークおよびホスト名 画面では、ワイヤレスオプションを選択できます。右側のペインで ネットワークの選択 をクリックして Wifi 接続を選択します。必要に応じてパスワードを入力し、完了 をクリックします。

4.3.4.1. 仮想ネットワークインターフェイスの追加

この手順では、仮想ネットワークインターフェイスを追加する方法を説明します。

手順

- ネットワークとホスト名 画面で、+ ボタンをクリックして、仮想ネットワークインターフェイスを追加します。デバイスの追加 ダイアログが開きます。

使用可能な 4 つのタイプの仮想インターフェイスから 1 つ選択してください。

- Bond: NIC (ネットワークインターフェイスコントローラー) のボンドです。複数の物理ネットワークインターフェイスを 1 つのボンドチャネルに結合する方法です。

- Bridge: NIC ブリッジングです。複数のネットワークを 1 つの集積ネットワークに接続します。

- Team: NIC のチーミングです。複数のリンクを集約する新しい実装方法です。小型のカーネルドライバーを提供することでパケットフローを高速で処理し、各種アプリケーションがその他のすべてのタスクをユーザー領域で行うように設計されています。

- Vlan (仮想 LAN): それぞれ独立している複数のブロードキャストドメインを作成する方法です。

インターフェイスの種類を選択し、追加 をクリックします。インターフェイスの編集ダイアログボックスが開き、選択したインターフェイスタイプに使用できる設定を編集できます。

詳細は、ネットワークインタフェース設定の変更 を参照してください。

- 保存 をクリックして仮想インターフェイス設定を確認し、ネットワークおよびホスト名 画面に戻ります。

仮想インターフェイスの設定を変更する必要がある場合は、インターフェイスを選択し、設定 をクリックします。

4.3.4.2. ネットワークインタフェース設定の変更

このセクションは、インストール時に使用される一般的な有線接続に最も重要な設定を説明します。その他の種類のネットワークの設定方法は、一部の設定パラメーターが異なる場合がありますが、ここで説明する内容とあまり変わりません。

64 ビットの IBM Z では、ネットワークサブチャンネルをあらかじめグループ化してオンラインに設定する必要があるため、新しい接続を追加することはできません。これは現在、起動段階でのみ行われます。

手順

手動でネットワーク接続を設定するには、ネットワークおよびホスト名 画面からインターフェイスを選択し、設定 をクリックします。

選択したインターフェイスに固有の編集ダイアログが開きます。

表示されるオプションは接続の種類によって異なります。使用可能なオプションは、接続の種類が物理インターフェイス (有線または無線のネットワークインターフェイスコントローラー) か、仮想インターフェイスの追加 で設定した仮想インターフェイス (ボンド、ブリッジ、チーム、または Vlan) かによって若干異なります。

4.3.4.3. インターフェイス接続の有効化または無効化

以下の手順に従って、インターフェイス接続を有効または無効にします。

手順

- 全般 タブをクリックします。

優先的に自動的に接続 チェックボックスを選択して、デフォルトで接続を有効にします。デフォルトの優先度設定は

0のままにします。重要-

有線接続で有効にすると、システムは起動時または再起動時に自動的に接続されます。無線接続では、インターフェイスにより、範囲内の既知の無線ネットワークへの接続が試されます。

nm-connection-editorツールを含む NetworkManager の詳細は、Configuring and managing networking のドキュメントを参照してください。 -

全ユーザーがこのネットワークに接続可能とする オプションを使用して、このシステムの全ユーザーがこのネットワークに接続するのを有効または無効にできます。このオプションを無効にすると、

rootだけがこのネットワークに接続できます。 -

インストール中のこの時点ではその他のユーザーが作成されないため、

root以外の特定のユーザーだけがこのインターフェイスを使用するように許可することはできません。別のユーザーが使用する接続が必要な場合は、インストール後に設定する必要があります。

-

有線接続で有効にすると、システムは起動時または再起動時に自動的に接続されます。無線接続では、インターフェイスにより、範囲内の既知の無線ネットワークへの接続が試されます。

- 保存 をクリックして変更を適用し、ネットワークおよびホスト名 画面に戻ります。

4.3.4.4. 静的な IPv4 または IPv6 の設定

デフォルトでは、現在のネットワーク設定に応じて、IPv4 と IPv6 の両方が自動設定に指定されています。つまり、ローカルの IP アドレス、DNS アドレスなどのアドレスは、インターフェイスがネットワークに接続すると自動的に検出されます。多くの場合はこれで十分ですが、IPv4 Settings タブと IPv6 Settings タブで静的な設定を行うこともできます。IPv4 設定または IPv6 設定を設定するには、以下の手順を実行します。

手順

静的ネットワーク設定を行うには、IPv 設定タブのいずれかに移動し、方式 ドロップダウンメニューから、自動 以外の方法 (手動 など) を選択します。アドレス ペインが有効になります。

注記IPv6 設定 タブでは、メソッドを 無視する に設定して、このインターフェイスの IPv6 を無効にできます。

- 追加 をクリックして、アドレス設定を入力します。

-

追加の DNS サーバー フィールドに IP アドレスを入力します。DNS サーバーの IP アドレス (

10.0.0.1,10.0.0.8など) を 1 つ以上設定できます。 この接続には IPvX アドレス設定が必要になります を選択します。

注記IPv4 または IPv6 が成功した場合にのみこの接続を許可するには、IPv4 設定 タブまたは IPv6 設定 タブでこのオプションを選択します。IPv4 および IPv6 の両方でこのオプションを無効にしたままにしておくと、いずれかの IP プロトコル設定に成功した場合にインターフェイスが接続できるようになります。

- 保存 をクリックして変更を適用し、ネットワークおよびホスト名 画面に戻ります。

4.3.4.5. ルートの設定

ルートを設定するには、以下の手順を実行します。

手順

- IPv4 設定 タブおよび IPv6 設定 タブで、ルート をクリックして特定の IP プロトコルのルーティング設定を行います。そのインターフェイス用のルート編集ダイアログが開きます。

- 追加 をクリックして、ルートを追加します。

- 1 つ以上の静的ルートを設定し、設定していないすべてのルートを無効にするには、自動的に得られたルートを無視する チェックボックスを選択します。

この接続はネットワーク上のリソースにのみ使用 チェックボックスを選択して、デフォルトルートにはならないようにします。

注記このオプションは、静的ルートを設定していなくても選択できます。このルートは、ローカルまたは VPN 接続を必要とするイントラネットページなど、特定のリソースにアクセスするためにのみ使用されます。公開されているリソースには別の (デフォルトの) ルートが使用されます。追加ルートが設定されているのとは異なり、この設定はインストール済みシステムに転送されます。このオプションは、複数のインターフェイスを設定する場合に限り役に立ちます。

- OK をクリックして設定を保存し、インターフェイス固有のルートの編集ダイアログボックスに戻ります。

- 保存 をクリックして設定を適用し、ネットワークおよびホスト名 画面に戻ります。

4.3.4.6. 関連情報

4.3.5. Red Hat への接続の設定

cdn.redhat.com で利用できる Red Hat コンテンツ配信ネットワーク (CDN) は、地理的に分散している一連の静的な Web サーバーです。これには、システムが使用するコンテンツとエラータが含まれます。コンテンツは、Red Hat Subscription Management に登録されたシステムを使用するなどして、直接使用できます。CDN は x.509 証明書認証で保護され、有効なユーザーのみがアクセスできるようにします。システムが Red Hat Subscription Management に登録されると、割り当てたサブスクリプションにより、システムがアクセスできる CDN のサブセットが管理されます。

CDN から RHEL を登録してインストールすると、以下の利点があります。

- CDN のインストール方法は、Boot ISO および DVD ISO のイメージファイルに対応します。ただし、大きな DVD ISO イメージファイルよりも領域が少ないため、小さい Boot ISO イメージファイルを使用することが推奨されます。

- CDN は最新のパッケージを使用するため、インストール直後は完全に最新のシステムになります。DVD ISO イメージファイルを使用する場合によくあるように、インストール直後にすぐにパッケージの更新をインストールする必要はありません。

- Red Hat Insights への接続、およびシステムの目的の有効化に対するサポートが統合されました。

4.3.5.1. システムの目的の概要

システムの目的は任意ですが、Red Hat Enterprise Linux インストールで推奨される機能です。システムの目的を使用して、Red Hat Enterprise Linux 8 システムの使用目的を記録し、エンタイトルメントサーバーがシステムに最も適したサブスクリプションを自動的に割り当てていることを確認します。

次の利点があります。

- システム管理および事業運営に関する詳細なシステムレベルの情報

- システムを調達した理由とその目的を判断する際のオーバーヘッドを削減

- Subscription Manager の自動割り当てと、システムの使用状況の自動検出および調整のカスタマーエクスペリエンスの向上

以下のいずれかの方法でシステムの目的のデータを入力できます。

- イメージの作成時

- Connect to Red Hat 画面を使用してシステムを登録し、Red Hat サブスクリプションを割り当てる際の GUI インストール時

- キックスタート自動化スクリプトを使用したキックスタートインストール時

-

subscription-manager syspurposeコマンドライン (CLI) ツールを使用したインストール後

システムの目的を記録するために、システムの目的の以下のコンポーネントを設定できます。選択された値は、登録時にエンタイトルメントサーバーが、システムに最適なサブスクリプションを割り当てるのに使用されます。

ロール

- Red Hat Enterprise Linux Server

- Red Hat Enterprise Linux Workstation

- Red Hat Enterprise Linux Compute Node

サービスレベルアグリーメント

- Premium

- Standard

- Self-Support

使用率

- Production

- Development/Test

- Disaster Recovery

4.3.5.2. Red Hat への接続オプションの設定

以下の手順に従って、GUI で Red Hat への接続オプションを設定します。

Red Hat アカウントまたはアクティベーションキーの詳細を使用して CDN に登録できます。

手順

アカウント をクリックします。

- Red Hat カスタマーポータルのユーザー名およびパスワードの詳細を入力します。

オプション:アクティベーションキー をクリックします。

- 組織 ID およびアクティベーションキーを入力します。サブスクリプションにアクティベーションキーが登録されている限り、複数のアクティベーションキーをコンマで区切って入力できます。

システムの目的の設定 チェックボックスを選択します。システムの目的を使用して、エンタイトルメントサーバーが Red Hat Enterprise Linux 8 システムの使用目的を満たすために、最適なサブスクリプションを自動的に判断して割り当てることができます。

- ドロップダウンリストから必要な ロール、SLA、および 使用方法 を選択します。

Red Hat Insights への接続 チェックボックスはデフォルトで有効になっています。Red Hat Insights に接続する必要がない場合には、チェックボックスの選択を解除します。

注記Red Hat Insights は SaaS (Software-as-a-Service) 製品で、継続的に、登録済みの Red Hat ベースのシステムに詳細な分析を提供し、物理環境、仮想環境、クラウド環境、およびコンテナーデプロイメントでセキュリティー、パフォーマンス、および安定性に関する脅威をプロアクティブに特定します。

オプション:オプション をデプロイメントします。

- ネットワーク環境で、外部のインターネットアクセスまたは HTTP プロキシーを介したコンテンツサーバーへのアクセスのみが許可されている場合は、HTTP プロキシーの使用 チェックボックスを選択します。HTTP プロキシーを使用していない場合は、HTTP プロキシーの使用 チェックボックスの選択を解除します。

Satellite Server を実行しているか、内部テストを実行している場合は、カスタムサーバーの URL チェックボックスと カスタムベース URL チェックボックスを選択して、必要な情報を入力します。

重要-

カスタムサーバーの URL フィールドには HTTP プロトコル (

nameofhost.comなど) が必要ありません。ただし、Custom base URL フィールドには HTTP プロトコルが必要です。 - 登録後に カスタムベース URL を変更するには、登録を解除し、新しい詳細を指定してから再登録する必要があります。

-

カスタムサーバーの URL フィールドには HTTP プロトコル (

登録 をクリックしてシステムを登録します。システムが正常に登録され、サブスクリプションが割り当てられると、Red Hat への接続 ウィンドウに、割り当てられているサブスクリプションの詳細が表示されます。

注記サブスクリプションのサイズによっては、登録および割り当てのプロセスが完了するのに最大 1 分かかることがあります。

完了 をクリックして、インストール概要 画面に戻ります。

- Red Hat への接続 の下に 登録 メッセージが表示されます。

4.3.5.3. システム登録後のインストールソースリポジトリー

システム登録後に使用されるインストールソースリポジトリーは、システムの起動方法により異なります。

- Boot ISO または DVD ISO のイメージファイルから起動するシステム

-

Boot ISOまたはDVD ISOのいずれかのイメージファイルを使用して、デフォルトの起動パラメーターを使用して RHEL インストールを起動した場合、インストールプログラムは、登録後にインストールソースリポジトリーを CDN に自動的に切り替えます。 inst.repo=<URL>ブートパラメーターで起動したシステム-

起動パラメーター

inst.repo=<URL>を使用して RHEL インストールを起動すると、インストールプログラムは、登録後に自動的にインストールソースリポジトリーを CDN に切り替えません。CDN を使用して RHEL をインストールする場合は、グラフィカルインストールの インストールソース 画面で Red Hat CDN オプションを選択し、インストールソースリポジトリーを CDN に手動で切り替える必要があります。CDN に手動で切り替えないと、インストールプログラムは、カーネルコマンドラインで指定されたリポジトリーからパッケージをインストールします。

-

キックスタートコマンドの

rhsmを使用してインストールソースリポジトリーを CDN に切り替えることができるのは、カーネルコマンドラインのinst.repo=またはキックスタートファイルのurlコマンドを使用してインストールソースを指定しない場合に限定されます。インストールイメージを取得するには、カーネルコマンドラインでinst.stage2=<URL>を使用する必要がありますが、インストールソースは指定しないでください。 -

起動オプションを使用して指定したインストールソース URL、またはキックスタートファイルに含まれるインストールソース URL は、キックスタートファイルに有効な認証情報を持つ

rhsmコマンドが含まれている場合でも CDN よりも優先されます。システムが登録されていますが、URL インストールソースからインストールされています。これにより、以前のインストールプロセスが通常通りに動作するようになります。

4.3.5.4. CDN からシステム登録の確認

以下の手順に従って、GUI で、システムが CDN に登録されていることを確認します。

インストール概要 画面から インストールの開始 ボタンを クリックしていない 場合に限り、CDN から登録を確認できます。インストールの開始 ボタンをクリックしたら、インストール概要画面に戻って登録を確認することができなくなります。

前提条件

- GUI を使用した CDN からの登録およびインストール に従って登録プロセスを完了し、インストール概要 画面の Red Hat への接続 の下に 登録済 と表示されている。

手順

- インストール概要 画面で、Red Hat への接続 を選択します。

ウィンドウが開き、登録の概要が表示されます。

- 方法

- 登録済みアカウント名またはアクティベーションキーが表示されます。

- システムの目的

- 設定されていると、ロール、SLA、使用方法の詳細が表示されます。

- Insights

- 有効にすると、Insights の詳細が表示されます。

- サブスクリプションの数

- 割り当てたサブスクリプションの数が表示されます。注記:シンプルコンテンツアクセスモードでは、サブスクリプションがリスト表示されないのは有効な動作です。

- 登録概要が、入力した詳細と一致していることを確認します。

4.3.5.5. CDN からシステムの登録解除

以下の手順に従って、GUI で CDN からシステムの登録を解除します。

- インストール概要 画面から インストールの開始 ボタンを クリックしていない 場合は、CDN から登録を解除できます。インストールの開始 ボタンをクリックしたら、インストール概要画面に戻って登録を解除することができなくなります。

登録を解除すると、インストールプログラムは、利用可能な最初のリポジトリーに以下の順序で切り替えます。

- カーネルコマンドラインの inst.repo=<URL> 起動パラメーターで使用される URL

- インストールメディア (USB または DVD) で自動的に検出されるリポジトリー

前提条件

- CDN から RHEL の登録およびインストール に従って登録プロセスを完了し、インストール概要 画面の Red Hat への接続 の下に 登録済 と表示されている。

手順

- インストール概要 画面で、Red Hat への接続 を選択します。

Red Hat への接続 画面が開き、登録の概要が表示されます。

- 方法

- 使用される登録アカウント名またはアクティベーションキーが表示されます。

- システムの目的

- 設定されていると、ロール、SLA、使用方法の詳細が表示されます。

- Insights

- 有効にすると、Insights の詳細が表示されます。

- サブスクリプションの数

- 割り当てたサブスクリプションの数が表示されます。注記:シンプルコンテンツアクセスモードでは、サブスクリプションがリスト表示されないのは有効な動作です。

- 登録解除 をクリックして、CDN から登録を削除します。元の登録情報が表示され、画面の中央下部に 未登録 メッセージが表示されます。

- 完了 をクリックして、インストール概要 画面に戻ります。

- Red Hat への接続 に 未登録 メッセージが表示され、ソフトウェアの選択 には Red Hat CDN では登録が必要です メッセージが表示されます。

システムの登録を解除したら、システムを再登録できます。Red Hat への接続 をクリックします。以前入力した詳細が入力されます。元の詳細情報を編集するか、アカウント、目的、および接続に基づいてフィールドを更新します。登録 をクリックして終了します。

4.3.5.6. 関連情報

- Red Hat Insights の詳細は、Red Hat Insights の製品ドキュメント を参照してください。

- アクティベーションキーの詳細は、Red Hat サブスクリプション管理の使用 ドキュメントの アクティベーションキーについて の章を参照してください。

-

Subscription Manager の HTTP プロキシーの設定方法は、

subscription-managerman ページのPROXY CONFIGURATIONセクションを参照してください。

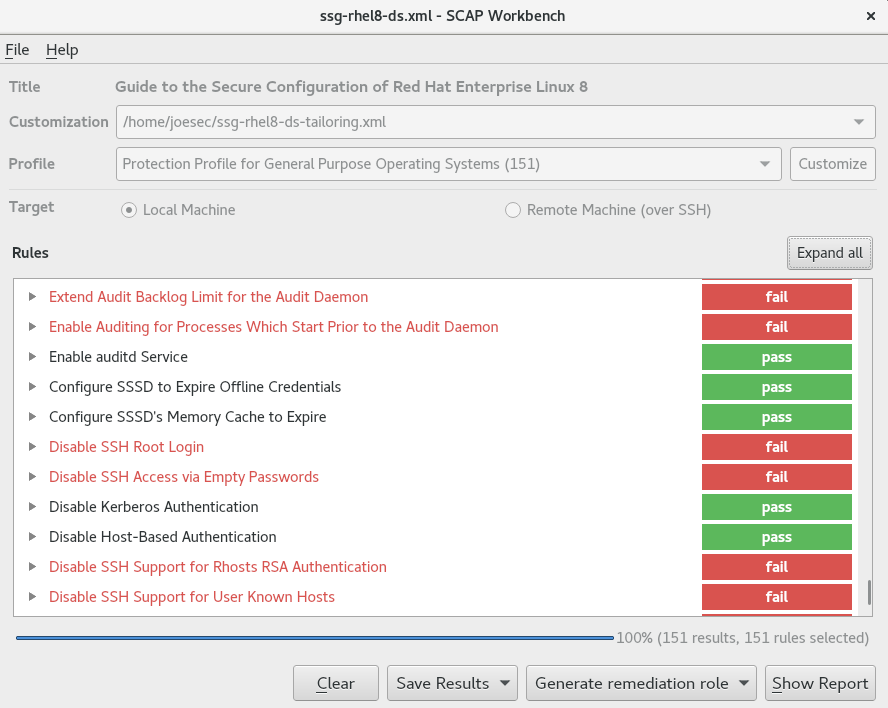

4.3.6. セキュリティーポリシーに沿ったシステムのインストール

本セクションは、インストール時に Red Hat Enterprise Linux 8 セキュリティーポリシーを適用する方法と、初めて起動する前にシステムで使用するように設定する方法を説明します。

4.3.6.1. セキュリティーポリシーの概要

Red Hat Enterprise Linux には、特定のセキュリティーポリシーに合わせてシステムの自動設定を有効にする OpenSCAP スイートが同梱されています。このポリシーは、SCAP (Security Content Automation Protocol) 標準を使用して実装されます。パッケージは、AppStream リポジトリーで利用できます。ただし、デフォルトでは、インストールおよびインストール後のプロセスではポリシーが強制されないため、特に設定しない限りチェックは行われません。

インストールプログラムでは、セキュリティーポリシーを適用することは必須ではありません。セキュリティーポリシーを適用する場合は、選択したプロファイルに定義した制限および推奨事項を使用してインストールされます。openscap-scanner パッケージおよび scap-security-guide パッケージがパッケージ選択に追加され、コンプライアンスおよび脆弱性スキャンのプリインストールツールが利用できるようになります。

セキュリティーポリシーを選択すると、Anaconda GUI インストーラーでは、ポリシーの要件に準拠する設定が必要になります。パッケージの選択が競合したり、別のパーティションが定義されている場合があります。要件がすべて満たされた場合に限り、インストールを開始できます。

インストールプロセスの終了時に、選択した OPEnSCAP セキュリティーポリシーにより、システムが自動的に強化され、スキャンされてコンプライアンスが確認され、インストール済みシステムの /root/openscap_data ディレクトリーにスキャン結果が保存されます。

デフォルトでは、インストーラーは、インストールイメージにバンドルされている scap-security-guide パッケージの内容を使用します。外部コンテンツは、HTTP サーバー、HTTPS サーバー、または FTP サーバーから読み込むこともできます。

4.3.6.2. セキュリティーポリシーの設定

セキュリティーポリシーを設定するには、以下の手順を実行します。

前提条件

インストール概要 画面が開いている。

手順

- インストール概要 画面から、セキュリティーポリシー をクリックします。セキュリティーポリシー 画面が開きます。

- システムでセキュリティーポリシーを有効にするには、セキュリティーポリシーの適用 を ON に切り替えます。

- 上部ペインに表示されているプロファイルから 1 つ選択します。

プロファイルを選択 をクリックします。

インストール前に適用が必要なプロファイルの変更が、下部ペインに表示されます。

カスタムプロファイルを使用するには、コンテンツの変更 をクリックします。別の画面が開いて、有効なセキュリティーコンテンツの URL を入力できます。

- 取得 をクリックして URL を取得します。

SCAP セキュリティーガイドを使用する をクリックして、セキュリティーポリシー 画面に戻ります。

注記HTTP サーバー、HTTPS サーバー、または FTP サーバーから、カスタムプロファイルを読み込むこともできます。コンテンツのフルアドレス (http:// などのプロトコルを含む) を使用してください。カスタムプロファイルを読み込む前に、ネットワーク接続がアクティブになっている必要があります。インストールプログラムは、コンテンツの種類を自動的に検出します。

- 完了 をクリックして設定を適用し、インストール概要 画面に戻ります。

4.3.6.3. 関連情報

-

scap-security-guide(8)-scap-security-guideプロジェクトの man ページには、SCAP セキュリティープロファイルに関する情報と、OpenSCAP ユーティリティーを使用して提供されているベンチマークの使用例が記載されています。 - Red Hat Enterprise Linux のセキュリティーのコンプライアンス情報は、セキュリティーの強化 を参照してください。

4.4. ソフトウェア設定の設定

このセクションは、インストールソースおよびソフトウェア選択設定を設定し、リポジトリーをアクティベートする方法を説明します。

4.4.1. インストールソースの設定

以下の手順を完了して、自動検出したインストールメディア、Red Hat CDN、またはネットワークからインストールソースを設定します。

インストール概要 画面を最初に開いた時に、インストールプログラムが、システムの起動に使用されたメディアの種類に基づいて、インストールソースを設定しようとします。完全な Red Hat Enterprise Linux Server DVD は、ソースをローカルメディアとして設定します。

前提条件

- 完全なインストールイメージをダウンロードしている。詳細は、RHEL インストール ISO イメージのダウンロード を参照してください。

- 起動可能な物理メディアを作成している。詳細は、起動可能な CD または DVD の作成 を参照してください。

- インストール概要 画面が開いている。

手順

インストール概要 画面から、インストールソース をクリックします。インストールソース 画面が開きます。

- 自動検出したインストールメディア セクションを見直して、詳細を確認します。インストールソースを含むメディア (DVD) からインストールプログラムを起動した場合は、このオプションがデフォルトで選択されます。

- 検証 をクリックして、メディアの整合性を確認します。

追加のリポジトリー セクションを確認してください。デフォルトでは AppStream チェックボックスが選択されています。

重要- BaseOS リポジトリーと AppStream リポジトリーはフルインストールイメージでインストールされるため、追加の設定は必要ありません。

- Red Hat Enterprise Linux 8 のフルインストールを行う場合は、AppStream リポジトリーのチェックボックスを無効にしないでください。

- オプション: Red Hat CDN オプションを選択して、システムを登録し、RHEL サブスクリプションを割り当てて、Red Hat コンテンツ配信ネットワーク (CDN) から RHEL をインストールします。詳細はCDN から RHEL の登録およびインストールを参照してください。

オプション:ネットワーク上 オプションを選択して、ローカルメディアの代わりに、ネットワーク上からパッケージをダウンロードしてインストールします。

注記- ネットワーク経由でその他のリポジトリーをダウンロードしてインストールしない場合は ソフトウェア選択の設定 に進みます。

- このオプションは、ネットワーク接続がアクティブな場合にのみ利用できます。GUI でネットワーク接続を設定する方法は ネットワークおよびホスト名のオプションの設定 を参照してください。

- ネットワーク上 ドロップダウンメニューを選択し、パッケージのダウンロードに使用するプロトコルを指定します。この設定は、使用するサーバーによって異なります。

アドレスフィールドに、(プロトコルなしで) サーバーアドレスを入力します。NFS を選択すると、入力フィールドが開き、カスタムの NFS マウントオプション を指定できます。このフィールドでは、

nfs(5)の man ページに含まれるオプションを使用できます。重要NFS のインストールソースを選択する際には、アドレスを指定する必要があります。ホスト名とパスはコロン (

:) で区切ります。以下に例を示します。server.example.com:/path/to/directory注記以下の手順は任意で、ネットワークアクセスにプロキシーが使用されているかどうかのみが必要となります。

- プロキシーの設定... をクリックして、HTTP または HTTPS のソースにプロキシーを設定します。

- HTTP プロキシーの有効化 チェックボックスを選択し、プロキシーホスト フィールドに URL を入力します。

- プロキシーサーバーで認証が必要な場合は、認証を使用する チェックボックスを選択します。

- ユーザー名とパスワードを入力します。

OK をクリックして設定を終了し、プロキシーの設定... ダイアログボックスを終了します。

注記HTTP または HTTPS の URL が、リポジトリーミラーを参照する場合は、URL type ドロップダウンリストから必要なオプションを選択します。ソースの設定が終わると、選択に対して環境と追加のソフトウェアパッケージがすべて利用できます。

- + をクリックして、リポジトリーを追加します。

- - をクリックして、リポジトリーを削除します。

- 矢印 アイコンをクリックして、現在のエントリーを、 インストールソース 画面を開いたときに表示されていた設定に戻します。

リポジトリーを有効または無効にするには、リストの各エントリーで 有効 列のチェックボックスをクリックします。

注記ネットワークにプライマリーリポジトリーを設定するときと同じように、追加リポジトリーに名前を付けて設定できます。

- 完了 をクリックして設定を適用し、インストール概要 画面に戻ります。

4.4.2. ソフトウェア選択の設定

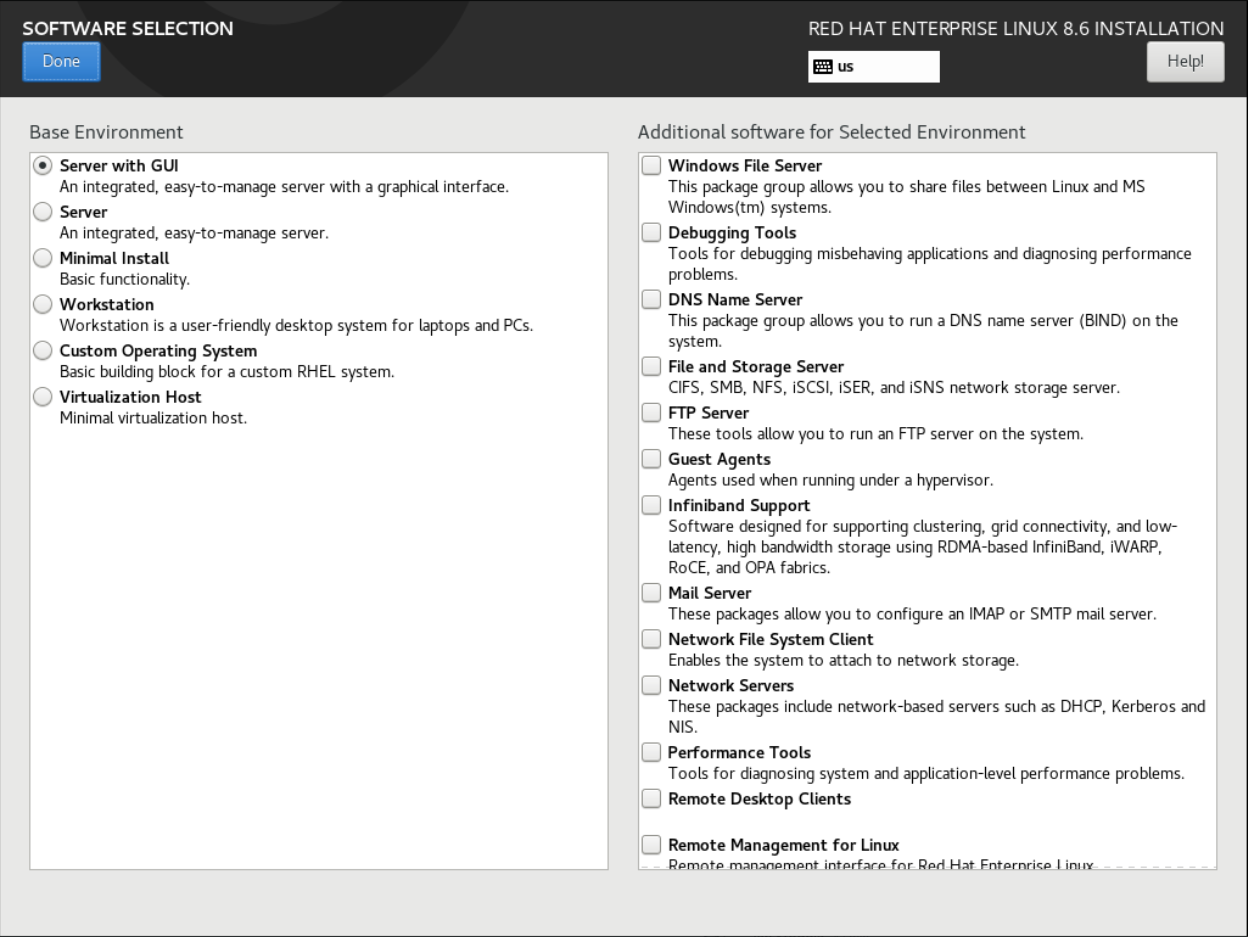

必要なソフトウェアパッケージを選択するには、ソフトウェアの選択 画面を使用します。パッケージはベース環境と追加ソフトウェアにより設定されています。

- ベース環境 には、事前に定義されたパッケージが含まれます。たとえば、Server with GUI (デフォルト)、Server、Minimal Install、Workstation、Custom Operating System、Custom Operating System など、基本環境を 1 つだけ選択できます。可用性は、インストールソースとして使用されているインストール ISO イメージにより異なります。

- 選択した環境の追加ソフトウェア には、ベース環境用の追加のソフトウェアパッケージが含まれています。複数のソフトウェアパッケージを選択できます。

事前に定義された環境と追加のソフトウェアを使用して、システムをカスタマイズします。ただし、標準的なインストールでは、インストールする個々のパッケージを選択することはできません。特定の環境に含まれるパッケージを表示するには、インストールソースメディア (DVD、CD、USB) にある repository/repodata/*-comps-repository.architecture.xml ファイルを参照してください。XML ファイルには、ベース環境としてインストールされたパッケージの詳細が記載されています。利用可能な環境には <environment> タグ、そして追加のソフトウェアパッケージには <group> タグが付いています。

Red Hat は、インストールするパッケージが分からない場合は、最小インストール のベース環境を選択することを推奨します。最小インストールでは、基本バージョンの Red Hat Enterprise Linux と、最低限の追加ソフトウェアがインストールされます。システムのインストールが終了して初めてログインしたら、YUM パッケージマネージャー を使用して、必要なソフトウェアをインストールできます。Yum パッケージマネージャーの詳細は、基本的なシステム設定の設定 を参照してください。

-

yum group listコマンドを実行すると、yum リポジトリーのパッケージグループリストが表示されます。詳細は 基本的なシステム設定の設定 を参照してください。 -

インストールするパッケージを制御する必要がある場合は、キックスタートファイルの

%packagesセクションにパッケージを定義します。キックスタートを使用して Red Hat Enterprise Linux をインストールする方法は、高度な RHEL 8 インストールの実行 を参照してください。

前提条件

- インストールソースを設定している。

- インストールプログラムが、パッケージのメタデータをダウンロードしている。

- インストール概要 画面が開いている。

手順

- インストール概要 画面で、ソフトウェアの選択 をクリックします。ソフトウェアの選択 画面が開きます。

ベース環境 ペインで、ベース環境を選択します。たとえば、Server with GUI (デフォルト)、Server、Minimal Install、Workstation、Custom Operating System、Custom Operating System など、基本環境を 1 つだけ選択できます。

注記サーバー (GUI 使用) ベース環境はデフォルトのベース環境で、インストールを完了してシステムを再起動すると、初期セットアップ アプリケーションが起動します。

図4.1 Red Hat Enterprise Linux ソフトウェアの選択

- 選択した環境の追加ソフトウェア ペインから、1 つ以上のオプションを選択します。

- Done をクリックして設定を適用し、グラフィカルインストール に戻ります。

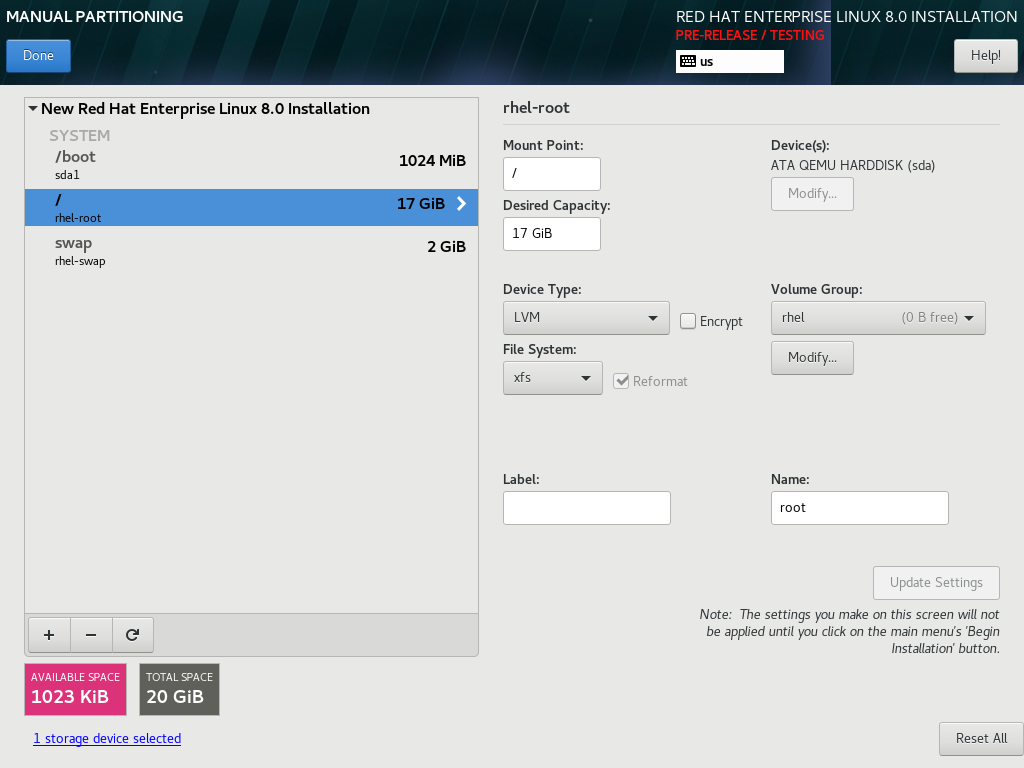

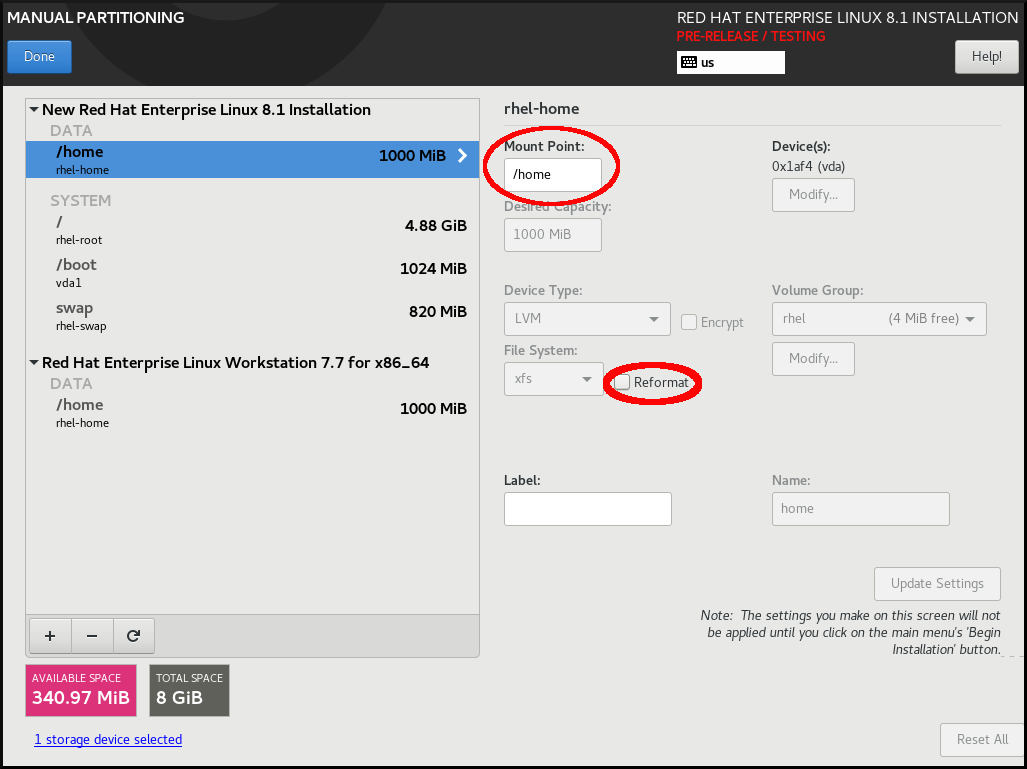

4.5. ストレージデバイスの設定

さまざまなストレージデバイスに Red Hat Enterprise Linux をインストールできます。インストール先 画面で、ローカルでアクセス可能な、基本的なストレージデバイスを設定できます。ハードディスクドライブやソリッドステートドライブなどのローカルシステムに直接接続する基本的なストレージデバイスは、その画面の ローカルの標準ディスク セクションに表示されます。64 ビットの IBM Z の場合は、このセクションに、アクティベートした DASD (Direct Access Storage Devices) が含まれます。

既知の問題により、HyperPAV エイリアスとして設定した DASD を、インストールの完了後に自動的にシステムに割り当てることができません。このようなストレージデバイスはインストール時に利用できますが、インストールが完了して再起動しても、すぐにはアクセスできません。HyperPAV エイリアスデバイスを接続するには、システムの /etc/dasd.conf 設定ファイルに手動で追加します。

4.5.1. ストレージデバイスの選択

ストレージデバイス選択画面には、インストールプログラムがアクセスできるストレージデバイスがリスト表示されます。システムや利用可能なハードウェアによっては、一部のタブが表示されない場合があります。デバイスは、次のタブに分類されます。

- マルチパスデバイス

同じシステムにある、複数の SCSI コントローラーやファイバーチャネルポートなどの複数のパスからアクセスできるストレージデバイスです。

重要インストールプログラムで検出できるのは、16 文字または 32 文字の長さのシリアル番号を持つマルチパスストレージデバイスのみです。

- その他の SAN デバイス

- SAN (Storage Area Network) 上にあるデバイスです。

- ファームウェア RAID

- ファームウェア RAID コントローラーに接続されているストレージデバイスです。

- NVDIMM デバイス

- 特定の状況下では、Red Hat Enterprise Linux 8 は、Intel 64 アーキテクチャーおよび AMD64 アーキテクチャー上で、(NVDIMM) デバイスからセクターモードで起動および実行できます。

- System z デバイス

- zSeries Linux FCP (ファイバーチャネルプロトコル) ドライバーで接続されたストレージデバイスもしくは LUN (論理ユニット) です。

4.5.2. ストレージデバイスのフィルタリング

ストレージデバイス選択画面では、WWID (World Wide Identifier)、ポート、ターゲット、または論理ユニット番号 (LUN) のいずれかを使用して、ストレージデバイスをフィルタリングできます。

前提条件

インストール概要 画面が開いている。

手順

- インストール概要 画面から、インストール先 をクリックします。インストール先 画面が開き、利用可能なドライブのリストが表示されます。

- 特殊なディスクおよびネットワークディスク セクションで ディスクの追加…をクリックします。ストレージデバイスの選択画面が表示されます。

ポート、ターゲット、LUN、または WWID で検索するには、検索項目 タブをクリックします。

WWID または LUN で検索するには、対応する入力テキストフィールドに値を入力する必要があります。

- 検索 ドロップダウンメニューから、必要なオプションを選択します。

- 検索 をクリックして検索を開始します。各デバイスと、対応するチェックボックスが、別の行に表示されます。

インストールプロセス時に必要なデバイスが利用できるようにするには、チェックボックスを選択します。

後続のインストールプロセスで、選択したデバイスの中から、Red Hat Enterprise Linux をインストールするデバイスを選択できます。その他のデバイスの中から、インストール済みシステムに自動的にマウントするものを選択できます。

注記- 選択したデバイスがインストールプロセスにより自動的に消去されることはなく、デバイスを選択しても、デバイスに保存されているデータが危険にさらされることはありません。

-

インストール後に

/etc/fstabファイルを変更することで、システムにデバイスを追加できます。

- 完了 をクリックして、インストール先 画面に戻ります。

ここで選択しないストレージデバイスはすべて、インストールプログラムでは表示されなくなります。別のブートローダーからこのブートローダーをチェーンロードする場合は、ここに表示されているすべてのデバイスを選択します。

4.5.3. 高度なストレージオプションの使用

高度なストレージデバイスを使用するには、iSCSI (SCSI over TCP/IP) ターゲットまたは FCoE (Fibre Channel over Ethernet) の SAN (Storage Area Network) を設定できます。

インストールに iSCSI ストレージデバイスを使用する場合は、インストールプログラム側で iSCSI ストレージデバイスを iSCSI ターゲットとして検出し、そのターゲットにアクセスするための iSCSI セッションを作成できるようにする必要があります。各手順で、CHAP (Challenge Handshake Authentication Protocol) 認証用のユーザー名とパスワードが必要になる場合があります。さらに、検出、またはセッション作成のいずれの場合も、iSCSI ターゲット側でターゲットの接続先となるシステムの iSCSI イニシエーターを認証する (リバース CHAP) ように設定することもできます。CHAP とリバース CHAP を併用する場合は、相互 CHAP または双方向 CHAP と呼ばれます。相互 CHAP を使用すると、特に CHAP 認証とリバース CHAP 認証でユーザー名やパスワードが異なる場合などに、iSCSI 接続に対する最大限の安全レベルを確保できます。

iSCSI 検出と iSCSI ログインの手順を繰り返して、必要な iSCSI ストレージをすべて追加します。初回の検出試行後は、iSCSI イニシエーターの名前を変更できません。iSCSI イニシエーターの名前を変更する場合は、インストールを最初からやり直す必要があります。

4.5.3.1. iSCSI セッションの検出および開始

次の手順を完了して、iSCSI セッションを検出して開始する方法を説明します。

前提条件

- インストール概要 画面が開いている。

手順

- インストール概要 画面から、インストール先 をクリックします。インストール先 画面が開き、利用可能なドライブのリストが表示されます。

- 特殊なディスクおよびネットワークディスク セクションで ディスクの追加..) クリックします。ストレージデバイスの選択画面が表示されます。

iSCSI ターゲットを追加...) クリックします。iSCSI ストレージターゲットの追加 画面が開きます。

重要この方法を使用して手動で追加した iSCSI ターゲットには

/bootパーティションを置くことができません。/bootパーティションを含む iSCSI ターゲットを iBFT で使用するように設定する必要があります。ただし、インストールされたシステムが、たとえば iPXE を使用して、ファームウェアの iBFT 以外の方法で提供された iBFT 設定で iSCSI から起動する場合は、inst.nonibftiscsibootインストーラー起動オプションを使用して/bootパーティション制限を削除できます。- ターゲットの IP アドレス フィールドに、iSCSI ターゲットの IP アドレスを入力します。

iSCSI イニシエーター名 フィールドに、iSCSI 修飾名 (IQN) の形式で iSCSI イニシエーターの名前を入力します。IQN エントリーには次を含めてください。

-

iqn.の文字列 (ピリオドが必要)。 -

日付コード (企業や組織のインターネットドメイン名またはサブドメイン名が登録された年と月。記述の順序は年を表す 4 桁の数字、ハイフン、月を表す 2 桁の数字、ピリオドの順で設定されます)。たとえば、2010 年 9 月の場合は

2010-09.のようになります。 -

企業や組織のインターネットのドメイン名またはサブドメイン名 (トップレベルのドメインを先頭にして逆順で表します)。たとえば、

storage.example.comのサブドメインは、com.example.storageのようになります。 コロン (:) と、ドメインまたはサブドメイン内でその iSCSI イニシエーターを固有に識別する文字列。たとえば、

:diskarrays-sn-a8675309のようになります。完全な IQN は

iqn.2010-09.storage.example.com:diskarrays-sn-a8675309のようになります。インストールプログラムでは、IQN を設定しやすいように、この形式による任意の名前がすでにiSCSI Initiator Nameフィールドに自動入力されています。IQN の詳細は、tools.ietf.org の RFC 3720 - Internet Small Computer Systems Interface (iSCSI) に記載されている 3.2.6. iSCSI Names と、tools.ietf.org の RFC 3721 - Internet Small Computer Systems Interface (iSCSI) Naming and Discovery に記載されている 1. iSCSI Names and Addresses を参照してください。

-

認証のタイプの探索ドロップダウンメニューを使用して、iSCSI 検出に使用する認証タイプを指定します。以下のタイプが使用できます。- 証明書なし

- CHAP 秘密鍵

- CHAP 秘密鍵と逆順鍵

-

認証タイプに

CHAP ペアを選択した場合は、CHAP ユーザー名とCHAP パスワードの各フィールドに、iSCSI ターゲットのユーザー名とパスワードを入力します。 -

認証タイプに

CHAP 秘密鍵と逆順鍵を選択した場合は、CHAP ユーザー名とCHAP パスワードの各フィールドに、iSCSI ターゲットのユーザー名とパスワードを入力します。また、リバース CHAP ユーザー名とCHAP パスワードの各フィールドに、iSCSI イニシエーターのユーザー名とパスワードを入力します。

-

認証タイプに

-

必要に応じて、

ターゲットをネットワークインターフェイスへバインドするチェックボックスをオンにします。 探索を開始 をクリックします。

入力した情報に基づいて、インストールプログラムが iSCSI ターゲットを調べます。検出に成功すると、

iSCSI ターゲットを追加画面には、ターゲットで検出された iSCSI ノードのリストが表示されます。インストールに使用するノードのチェックボックスを選択します。

注記ノードのログイン認証のタイプメニューには、認証のタイプの探索メニューと同じオプションがあります。ただし、ディスカバリー認証に証明書が必要な場合は、見つかったノードに同じ証明書を使用してログインします。-