Red Hat Training

A Red Hat training course is available for RHEL 8

カーネルの管理、監視、および更新

Red Hat Enterprise Linux 8 上で Linux カーネルを管理するためのガイド

概要

多様性を受け入れるオープンソースの強化

Red Hat では、コード、ドキュメント、Web プロパティーにおける配慮に欠ける用語の置き換えに取り組んでいます。まずは、マスター (master)、スレーブ (slave)、ブラックリスト (blacklist)、ホワイトリスト (whitelist) の 4 つの用語の置き換えから始めます。この取り組みは膨大な作業を要するため、今後の複数のリリースで段階的に用語の置き換えを実施してまいります。詳細は、Red Hat CTO である Chris Wright のメッセージ をご覧ください。

Red Hat ドキュメントへのフィードバック (英語のみ)

Red Hat ドキュメントに関するご意見やご感想をお寄せください。また、改善点があればお知らせください。

Jira からのフィードバック送信 (アカウントが必要)

- Jira の Web サイトにログインします。

- 上部のナビゲーションバーで Create をクリックします。

- Summary フィールドにわかりやすいタイトルを入力します。

- Description フィールドに、ドキュメントの改善に関するご意見を記入してください。ドキュメントの該当部分へのリンクも追加してください。

- ダイアログの下部にある Create をクリックします。

第1章 Linux カーネル

Linux カーネルと、Red Hat が提供および管理する Linux カーネル RPM パッケージ (Red Hat カーネル) について学びます。Red Hat カーネルを最新の状態に保ちます。これにより、オペレーティングシステムに最新のバグ修正、パフォーマンス強化、およびパッチがすべて適用され、新しいハードウェアとの互換性が保たれます。

1.1. カーネルとは

カーネルは Linux オペレーティングシステムのコア部分で、システムリソースを管理し、ハードウェアアプリケーションおよびソフトウェアアプリケーション間のインターフェイスを確立します。

Red Hat カーネルは、アップストリームの Linux メインラインカーネルをベースにしたカスタムカーネルです。Red Hat のエンジニアは、安定性と、最新のテクノロジーおよびハードウェアとの互換性に重点を置き、さらなる開発と強化を行っています。

Red Hat が新しいカーネルバージョンをリリースする前に、カーネルは厳格な品質保証テストをクリアしなければなりません。

Red Hat カーネルは RPM 形式でパッケージ化されているため、yum パッケージマネージャーにより簡単にアップグレードおよび検証できます。

Red Hat によってコンパイルされていないカーネルは、Red Hat ではサポートされていません。

1.2. RPM パッケージ

RPM パッケージは、ファイルのアーカイブと、これらのファイルのインストールと消去に使用されるメタデータで構成されます。具体的には、RPM パッケージには次の要素が含まれています。

- GPG 署名

- GPG 署名は、パッケージの整合性を検証するために使用されます。

- RPM ヘッダー (パッケージのメタデータ)

- RPM パッケージマネージャーは、このメタデータを使用して、パッケージの依存関係、ファイルのインストール先、その他の情報を確認します。

- ペイロード

-

ペイロードは、システムにインストールするファイルを含む

cpioアーカイブです。

RPM パッケージには 2 つの種類があります。いずれも、同じファイル形式とツールを使用しますが、コンテンツが異なるため、目的が異なります。

- ソース RPM (SRPM)

- SRPM には、ソースコードと SPEC ファイルが含まれます。これには、ソースコードをバイナリー RPM にビルドする方法が書かれています。必要に応じて、SRPM にはソースコードへのパッチを含めることができます。

- バイナリー RPM

- バイナリー RPM には、ソースおよびパッチから構築されたバイナリーが含まれます。

1.3. Linux カーネル RPM パッケージの概要

カーネル RPM は、ファイルを含まないメタパッケージで、以下の必須サブパッケージが正しくインストールされるようにします。

kernel-core-

kernel-core- コア機能を確保するために、カーネルのバイナリーイメージ、システムを起動するためのすべての initramfs 関連オブジェクト、および最小限のカーネルモジュールが含まれます。このサブパッケージ単体は、仮想環境およびクラウド環境で使用して、Red Hat Enterprise Linux 8 カーネルのブート時間を短縮し、ディスクサイズを抑えます。 kernel-modules-

kernel-coreに存在しない残りのカーネルモジュールが含まれます。

上記の kernel サブパッケージをいくつか用意することで、特に仮想環境やクラウド環境でのシステム管理者へのメンテナンス面を低減させることを目指します。

任意のカーネルパッケージは、以下の例のようになります。

kernel-modules-extra- まれなハードウェア用のカーネルモジュールと、読み込みがデフォルトで無効になっているモジュールが含まれます。

kernel-debug- カーネル診断ができるように複数のデバッグオプションが有効になっているカーネルが含まれます。デバッグオプションが有効になっているとパフォーマンスが低下します。

kernel-tools- Linux カーネル操作のツールとサポートドキュメントが含まれています。

kernel-devel-

kernelパッケージに対して、モジュールをビルドするのに十分なカーネルヘッダーと makefiles を含んでいます。 kernel-abi-stablelists-

RHEL カーネル ABI に関連する情報が含まれています。これには、強化を支援するための外部 Linux カーネルモジュールおよび

dnfプラグインで必要なカーネルシンボルのリストが含まれます。 kernel-headers- Linux カーネルと、ユーザー空間ライブラリーおよびプログラムとの間のインターフェイスを指定する C ヘッダーファイルが含まれます。ヘッダーファイルは、ほとんどの標準プログラムを構築するのに必要な構造と定数を定義します。

1.4. カーネルパッケージの内容の表示

カーネルパッケージがモジュールなどの特定のファイルを提供しているかどうかを判断するには、リポジトリーにクエリーを実行して、アーキテクチャーのパッケージのファイルリストを表示します。ファイルリストを表示するためにパッケージをダウンロードまたはインストールする必要はありません。

dnf ユーティリティーを使用して、たとえば kernel-core、kernel-modules-core、または kernel-modules パッケージのファイルリストをクエリーします。kernel パッケージはファイルを含まないメタパッケージであることに注意してください。

手順

パッケージの利用可能なバージョンをリスト表示します。

$ yum repoquery <package_name>たとえば、

kernel-coreパッケージの利用可能なバージョンをリスト表示します。$ yum repoquery kernel-core kernel-core-0:4.18.0-147.0.2.el8_1.x86_64 kernel-core-0:4.18.0-147.0.3.el8_1.x86_64 kernel-core-0:4.18.0-147.3.1.el8_1.x86_64 kernel-core-0:4.18.0-147.5.1.el8_1.x86_64 kernel-core-0:4.18.0-147.8.1.el8_1.x86_64 kernel-core-0:4.18.0-147.el8.x86_64 …パッケージ内のファイルをリスト表示します。

$ yum repoquery -l <package_name>たとえば、

kernel-core-0:5.14.0-162.23.1.el9_1.x86_64パッケージ内のファイルをリスト表示します。$ yum repoquery -l kernel-core-0:4.18.0-147.8.1.el8_1.x86_64 /boot/.vmlinuz-4.18.0-147.8.1.el8_1.x86_64.hmac /boot/System.map-4.18.0-147.8.1.el8_1.x86_64 /boot/config-4.18.0-147.8.1.el8_1.x86_64 /boot/initramfs-4.18.0-147.8.1.el8_1.x86_64.img /boot/symvers-4.18.0-147.8.1.el8_1.x86_64.gz /boot/vmlinuz-4.18.0-147.8.1.el8_1.x86_64 /etc/ld.so.conf.d/kernel-4.18.0-147.8.1.el8_1.x86_64.conf /lib/modules /lib/modules/4.18.0-147.8.1.el8_1.x86_64 ...

関連情報

1.5. 特定のカーネルバージョンのインストール

yum パッケージマネージャーを使用して新しいカーネルをインストールします。

手順

特定のカーネルバージョンをインストールするには、次のコマンドを実行します。

# yum install kernel-{version}

1.6. カーネルの更新

yum パッケージマネージャーを使用してカーネルを更新します。

手順

カーネルを更新するには、次のコマンドを入力します。

# yum update kernelこのコマンドは、カーネルと、利用可能な最新バージョンへのすべての依存関係を更新します。

- システムを再起動して、変更を有効にします。

RHEL 7 から RHEL 8 にアップグレードする場合は、RHEL 7 から RHEL 8 へのアップグレード ドキュメントの関連のセクションを参照してください。

関連情報

1.7. カーネルのデフォルトとしての設定

grubby コマンドラインツールと GRUB を使用して、特定のカーネルをデフォルトとして設定します。

手順

grubbyツールを使用した、カーネルのデフォルトとしての設定以下のコマンドを実行し、

grubbyツールを使用してカーネルをデフォルトとして設定します。# grubby --set-default $kernel_pathコマンドは、

.confの接尾辞のないマシン ID を引数として使用します。注記マシン ID は

/boot/loader/entries/ディレクトリーにあります。

id引数を使用したカーネルのデフォルト設定id引数を使用してブートエントリーのリストを表示し、任意のカーネルをデフォルトとして設定します。# grubby --info ALL | grep id # grubby --set-default /boot/vmlinuz-<version>.<architecture>

注記title引数を使用してブートエントリーのリストを表示するには、# grubby --info=ALL | grep titleコマンドを実行します。

次回の起動時のみのデフォルトカーネルの設定

次のコマンドを実行し、

grub2-rebootコマンドを使用して、次回の再起動限定でデフォルトのカーネルを設定します。# grub2-reboot <index|title|id>警告取り扱いに注意して、次回の起動時限定のデフォルトのカーネルを設定します。新しいカーネル RPM、自己ビルドカーネルをインストールし、エントリーを

/boot/loader/entries/ディレクトリーに手動で追加すると、インデックス値が変更される可能性があります。

第2章 カーネルモジュールの管理

カーネルモジュール、それらの情報を表示する方法、およびカーネルモジュールを使用して基本的な管理タスクを実行する方法について学びます。

2.1. モジュールの紹介

Red Hat Enterprise Linux カーネルは、システムを再起動しなくても、カーネルモジュールと呼ばれる追加機能で拡張できます。RHEL 8 では、カーネルモジュールは、圧縮された <KERNEL_MODULE_NAME>.ko.xz オブジェクトファイルに組み込まれた追加のカーネルコードです。

カーネルモジュールにより有効になっている最も一般的な機能は、以下のとおりです。

- 新しいハードウェアへのサポートを強化するデバイスドライバー

- GFS2 や NFS などのファイルシステムのサポート

- システムコール

最新のシステムでは、必要に応じて自動的にカーネルモジュールが読み込まれます。ただし、場合によっては、モジュールを手動でロードまたはアンロードする必要があります。

モジュールは、カーネル自体と同様に、必要に応じてその動作をカスタマイズするパラメーターを受けることができます。

ツールでは、現在実行しているモジュール、カーネルに読み込みできるモジュール、モジュールが受け入れるパラメーターを調べることができます。このツールは、実行中のカーネルに、カーネルモジュールのロードおよびアンロードを行うためのメカニズムを提供します。

2.2. カーネルモジュールの依存関係

特定のカーネルモジュールは、複数の他のカーネルモジュールに依存する場合があります。/lib/modules/<KERNEL_VERSION>/modules.dep ファイルには、各カーネルバージョンに対するカーネルモジュールの依存関係の完全なリストが含まれます。

depmod

依存関係ファイルは、kmod パッケージの一部である depmod プログラムにより生成されます。kmod によるユーティリティーの多くは、操作を実行する際にモジュールの依存関係を考慮に入れるため、手動 で依存関係を追跡する必要はほとんどありません。

カーネルモジュールのコードは、制限のないモードのカーネルスペースで実行されます。そのため、読み込むモジュールに注意してください。

weak-modules

depmod に加えて、Red Hat Enterprise Linux は、同じく kmod パッケージに同梱されている weak-modules スクリプトを提供します。weak-modules は、どのモジュールがインストールされたカーネルと kABI 互換であるかを決定します。モジュールカーネルの互換性をチェックしている間、weak-modules はモジュールシンボルの依存関係を、それらがビルドされたカーネルの上位リリースから下位リリースへと処理します。これは、weak-modules がビルド対象のカーネルリリースとは無関係に各モジュールを処理することを意味します。

関連情報

-

modules.dep (5)man ページ -

depmod (8)man ページ - Red Hat Enterprise Linux に同梱されている weak-modules スクリプトの目的は何ですか?

- カーネルアプリケーションバイナリーインターフェイス (kABI) とは何ですか?

2.3. インストール済みカーネルモジュールのリスト表示

grubby --info=ALL コマンドは、!BLS インストールおよび BLS インストールにインストールされたカーネルのインデックスリストを表示します。

手順

以下のコマンドを使用して、インストールされているカーネルをリスト表示します。

# grubby --info=ALL | grep titleインストールされているカーネルのリストは、以下のようになります。

title=Red Hat Enterprise Linux (4.18.0-20.el8.x86_64) 8.0 (Ootpa) title=Red Hat Enterprise Linux (4.18.0-19.el8.x86_64) 8.0 (Ootpa) title=Red Hat Enterprise Linux (4.18.0-12.el8.x86_64) 8.0 (Ootpa) title=Red Hat Enterprise Linux (4.18.0) 8.0 (Ootpa) title=Red Hat Enterprise Linux (0-rescue-2fb13ddde2e24fde9e6a246a942caed1) 8.0 (Ootpa)

上記の例では、GRUB メニューから grubby-8.40-17 のインストール済みカーネルの一覧を表示します。

2.4. 現在読み込み済みカーネルモジュールのリスト表示

現在ロードされているカーネルモジュールを表示します。

前提条件

-

kmodパッケージがインストールされている。

手順

現在読み込み済みのカーネルモジュールの一覧を表示するには、以下のコマンドを実行します。

$ lsmod Module Size Used by fuse 126976 3 uinput 20480 1 xt_CHECKSUM 16384 1 ipt_MASQUERADE 16384 1 xt_conntrack 16384 1 ipt_REJECT 16384 1 nft_counter 16384 16 nf_nat_tftp 16384 0 nf_conntrack_tftp 16384 1 nf_nat_tftp tun 49152 1 bridge 192512 0 stp 16384 1 bridge llc 16384 2 bridge,stp nf_tables_set 32768 5 nft_fib_inet 16384 1 …上記の例では、以下のようになります。

-

Module列は、現在読み込まれているモジュールの 名前 を示します。 -

Size列は、モジュールごとの メモリー 容量をキロバイト単位で表示します。 -

Used by列には、特定のモジュールに 依存する モジュールの数と、オプションで名前が表示されます。

-

関連情報

-

/usr/share/doc/kmod/READMEファイル -

lsmod(8)の man ページ

2.5. インストール済みカーネルのリスト表示

grubby ユーティリティーを使用して、システムにインストールされているすべてのカーネルを一覧表示します。

前提条件

- root 権限がある。

手順

インストールされているすべてのカーネルを一覧表示するには、次のコマンドを実行します。

# grubby --info=ALL | grep ^kernel kernel="/boot/vmlinuz-4.18.0-305.10.2.el8_4.x86_64" kernel="/boot/vmlinuz-4.18.0-240.el8.x86_64" kernel="/boot/vmlinuz-0-rescue-41eb2e172d7244698abda79a51778f1b"

この出力には、インストールしたすべてのカーネルのパスと、各バージョンが表示されます。

2.6. モジュール情報の表示

modinfo コマンドを使用して、指定したカーネルモジュールに関する詳細情報を表示します。

前提条件

-

kmodパッケージがインストールされている。

手順

カーネルモジュールの情報を表示するには、以下を実行します。

$ modinfo <KERNEL_MODULE_NAME>以下に例を示します。

$ modinfo virtio_net filename: /lib/modules/4.18.0-94.el8.x86_64/kernel/drivers/net/virtio_net.ko.xz license: GPL description: Virtio network driver rhelversion: 8.1 srcversion: 2E9345B281A898A91319773 alias: virtio:d00000001v* depends: net_failover intree: Y name: virtio_net vermagic: 4.18.0-94.el8.x86_64 SMP mod_unload modversions … parm: napi_weight:int parm: csum:bool parm: gso:bool parm: napi_tx:bool読み込まれているかどうかに関わらず、利用可能なすべてのモジュールの情報を照会できます。

parmエントリーは、ユーザーがモジュールに設定できるパラメーターと、期待される値のタイプを示します。注記カーネルモジュールの名前を入力する際には、

.ko.xz拡張子は名前の末尾に追加しないでください。カーネルモジュール名には拡張子はありません。ただし、対応するファイルには拡張子があります。

関連情報

-

modinfo(8)の man ページ

2.7. システムランタイム時のカーネルモジュールの読み込み

Linux カーネルの機能を拡張する最適な方法は、カーネルモジュールを読み込むことです。modprobe コマンドを使用して、カーネルモジュールを検出し、現在実行しているカーネルに読み込みます。

この手順で説明されている変更は、システムを再起動は維持されません。システムの再起動後にも 設定を維持 するようにカーネルモジュールを読み込む方法は、システムの起動時に自動的にカーネルモジュールを読み込む を参照してください。

前提条件

- root 権限がある。

-

kmodパッケージがインストールされている。 - 関連のカーネルモジュールが読み込まれていない。これを確認するには、読み込まれているカーネルモジュール をリスト表示します。

手順

読み込むカーネルモジュールを選択します。

モジュールは

/lib/modules/$(uname -r)/kernel/<SUBSYSTEM>/ディレクトリーにあります。関連するカーネルモジュールを読み込みます。

# modprobe <MODULE_NAME>注記カーネルモジュールの名前を入力する際には、

.ko.xz拡張子は名前の末尾に追加しないでください。カーネルモジュール名には拡張子はありません。ただし、対応するファイルには拡張子があります。

検証

必要に応じて、関連モジュールが読み込まれたことを確認します。

$ lsmod | grep <MODULE_NAME>モジュールが正しく読み込まれた場合、このコマンドは関連するカーネルモジュールを表示します。以下に例を示します。

$ lsmod | grep serio_raw serio_raw 16384 0

関連情報

-

modprobe(8)の man ページ

2.8. システムランタイム時のカーネルモジュールのアンロード

時折、実行中のカーネルから特定のカーネルモジュールをアンロードする必要性に駆られることがあります。modprobe コマンドを使用して、現在読み込まれているカーネルから、システムの実行時にカーネルモジュールを見つけてアンロードします。

実行中のシステムで使用される場合は、カーネルモジュールをアンロードしないでください。これを行うと、システムが不安定になったり、動作しなくなったりすることがあります。

この手順を終了すると、システムの起動時に自動的に読み込まれるように定義したカーネルモジュールは、システムを再起動してもアンロードされません。この結果を追跡する方法は、システムの起動時にカーネルモジュールが自動的にロードされないようにする を参照してください。

前提条件

- root 権限がある。

-

kmodパッケージがインストールされている。

手順

ロード済みの全カーネルモジュールをリスト表示します。

# lsmodアンロードするカーネルモジュールを選択します。

カーネルモジュールに依存関係がある場合は、カーネルモジュールをアンロードする前に、これらをアンロードします。依存関係のあるモジュールを特定する方法は、Listing currently loaded kernel modules および Kernel module dependencies を参照してください。

関連するカーネルモジュールをアンロードします。

# modprobe -r <MODULE_NAME>カーネルモジュールの名前を入力する際には、

.ko.xz拡張子は名前の末尾に追加しないでください。カーネルモジュール名には拡張子はありません。ただし、対応するファイルには拡張子があります。

検証

必要に応じて、関連モジュールがアンロードされたことを確認します。

$ lsmod | grep <MODULE_NAME>モジュールが正常にアンロードされた場合、このコマンドは出力を表示しません。

関連情報

-

modprobe(8)の man ページ

2.9. 起動プロセスの初期段階でのカーネルモジュールのアンロード

特定の状況では、起動プロセスの初期段階でカーネルモジュールのアンロードが必要になります。たとえば、カーネルモジュールにコードが含まれているとシステムが応答しなくなり、ユーザーがステージに到達して不正なカーネルモジュールを永続的に無効にすることができません。その場合は、ブートローダーを使用して、カーネルモジュールの読み込みを一時的にブロックできます。

ブートシーケンスが続行する前に、関連するブートローダーエントリーを編集して、必要なカーネルモジュールをアンロードできます。

この手順で説明されている変更は、システムを再起動すると維持されません。起動プロセス時にカーネルモジュールが自動的に読み込まれないように、denylist にカーネルモジュールを追加する方法は、システムの起動時にカーネルモジュールが自動的にロードされないようにする を参照してください。

前提条件

- なんらかの理由で読み込みを阻止する必要のある、読み込み可能なカーネルモジュールがある。

手順

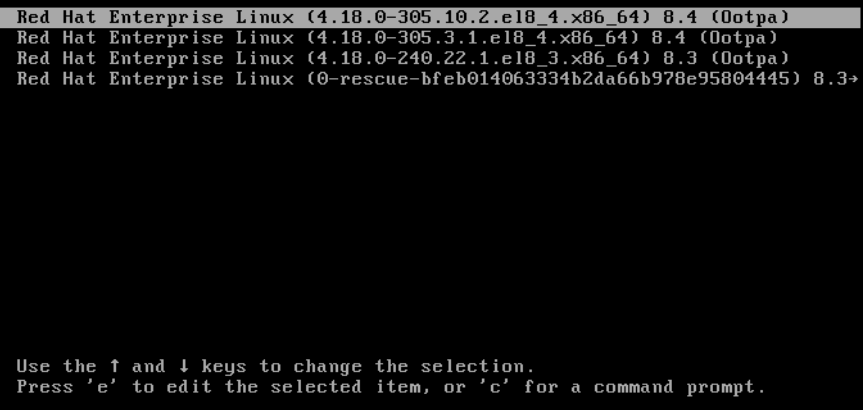

- システムをブートローダーで起動します。

- カーソルキーを使用して、関連するブートローダーエントリーを強調表示します。

e キーを押してエントリーを編集します。

図2.1 カーネルブートメニュー

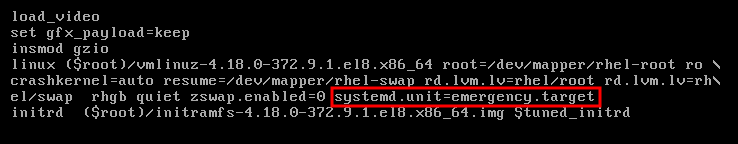

- カーソルキーを使用して、linux で始まる行に移動します。

modprobe.blacklist=module_nameを行末に追加します。図2.2 カーネルブートエントリー

serio_rawカーネルモジュールは、起動プロセスの初期段階でアンロードする不正なモジュールを示しています。- Ctrl+X を押して、変更した設定を使用して起動します。

検証

システムが完全に起動したら、関連するカーネルモジュールが読み込まれていないことを確認します。

# lsmod | grep serio_raw

関連情報

2.10. システムの起動時に自動的にカーネルモジュールを読み込む

ブートプロセス中に自動的に読み込まれるようにカーネルモジュールを設定します。

前提条件

- root 権限がある。

-

kmodパッケージがインストールされている。

手順

起動プロセス中に読み込むカーネルモジュールを選択します。

モジュールは

/lib/modules/$(uname -r)/kernel/<SUBSYSTEM>/ディレクトリーにあります。モジュールの設定ファイルを作成します。

# echo <MODULE_NAME> > /etc/modules-load.d/<MODULE_NAME>.conf注記カーネルモジュールの名前を入力する際には、

.ko.xz拡張子は名前の末尾に追加しないでください。カーネルモジュール名には拡張子はありません。ただし、対応するファイルには拡張子があります。必要に応じて、関連モジュールが読み込まれたことを確認します。

$ lsmod | grep <MODULE_NAME>上記のコマンド例は成功し、関連するカーネルモジュールを表示します。

この手順で説明している変更は、システムを再起動しても持続されます。

関連情報

-

modules-load.d(5)の man ページ

2.11. システムの起動時にカーネルモジュールが自動的にロードされないようにする

対応する コマンドを使用して、modprobe 設定ファイルにモジュールを一覧表示することで、起動プロセス中にシステムが自動的にカーネルモジュールを読み込むことを阻止できます。

前提条件

-

この手順のコマンドには root 権限が必要です。

su -を使用して root ユーザーに切り替えるか、コマンドの前にsudoを付けます。 -

kmodパッケージがインストールされている。 - 現在のシステム設定に、拒否する予定のカーネルモジュールが必要ないことを確認する。

手順

lsmodコマンドを使用して、現在実行中のカーネルに読み込まれているモジュールを一覧表示します。$ lsmod Module Size Used by tls 131072 0 uinput 20480 1 snd_seq_dummy 16384 0 snd_hrtimer 16384 1 …出力で、読み込みを阻止するモジュールを特定します。

または、

/lib/modules/<KERNEL-VERSION>/kernel/<SUBSYSTEM>/ディレクトリーに読み込まれないようにするアンロードしたカーネルモジュールを特定します。以下に例を示します。$ ls /lib/modules/4.18.0-477.20.1.el8_8.x86_64/kernel/crypto/ ansi_cprng.ko.xz chacha20poly1305.ko.xz md4.ko.xz serpent_generic.ko.xz anubis.ko.xz cmac.ko.xz…

拒否リストとして機能する設定ファイルを作成します。

# touch /etc/modprobe.d/denylist.conf任意のテキストエディターで、カーネルへの自動読み込みから除外するモジュール名を

blacklist設定コマンドと組み合わせます。以下に例を示します。# Prevents <KERNEL-MODULE-1> from being loaded blacklist <MODULE-NAME-1> install <MODULE-NAME-1> /bin/false # Prevents <KERNEL-MODULE-2> from being loaded blacklist <MODULE-NAME-2> install <MODULE-NAME-2> /bin/false …

blacklistコマンドは、モジュールが、拒否リストにない別のカーネルモジュールの依存関係として読み込まれることを阻止しないため、install行も定義する必要があります。この場合、システムはモジュールをインストールする代わりに/bin/falseを実行します。ハッシュ記号で始まる行は、ファイルをより読みやすくするために使用可能なコメントです。注記カーネルモジュールの名前を入力する際には、

.ko.xz拡張子は名前の末尾に追加しないでください。カーネルモジュール名には拡張子はありません。ただし、対応するファイルには拡張子があります。再構築を行う前に、現在の初期 RAM ディスクイメージのバックアップコピーを作成します。

# cp /boot/initramfs-$(uname -r).img /boot/initramfs-$(uname -r).bak.$(date +%m-%d-%H%M%S).imgまたは、カーネルモジュールの自動読み込みを阻止するカーネルバージョンに対応する初期 RAM ディスクイメージのバックアップコピーを作成します。

# cp /boot/initramfs-<VERSION>.img /boot/initramfs-<VERSION>.img.bak.$(date +%m-%d-%H%M%S)

新しい初期 RAM ディスクイメージを生成して、変更を適用します。

# dracut -f -vシステムで現在使用中のものとは異なるカーネルバージョンの初期 RAM ディスクイメージを構築する場合は、ターゲット

initramfsとカーネルバージョンの両方を指定します。# dracut -f -v /boot/initramfs-<TARGET-VERSION>.img <CORRESPONDING-TARGET-KERNEL-VERSION>

システムを再起動します。

$ reboot

この手順で説明している変更は、システムを再起動しても持続されます。拒否リストにキーカーネルモジュールを誤って記載した場合、システムを不安定または操作不能な状態に切り換えることができます。

関連情報

- ソリューション記事 How do I prevent a kernel module from loading automatically? を参照してください。

-

modprobe.d(5)およびdracut(8)の man ページ を参照してください。

2.12. カスタムカーネルモジュールのコンパイル

ハードウェアおよびソフトウェアレベルで、さまざまな設定による要求に応じて、サンプリングカーネルモジュールを構築できます。

前提条件

kernel-develパッケージ、gccパッケージ、およびelfutils-libelf-develパッケージをインストールしている。# dnf install kernel-devel-$(uname -r) gcc elfutils-libelf-devel

- root 権限がある。

-

カスタムカーネルモジュールをコンパイルする

/root/testmodule/ディレクトリーを作成している。

手順

以下の内容で

/root/testmodule/test.cを作成します。#include <linux/module.h> #include <linux/kernel.h> int init_module(void) { printk("Hello World\n This is a test\n"); return 0; } void cleanup_module(void) { printk("Good Bye World"); }test.cファイルは、カーネルモジュールに主な機能を提供するソースファイルです。このファイルは、組織的な目的で、専用の/root/testmodule/ディレクトリーに作成されています。モジュールをコンパイルすると、/root/testmodule/ディレクトリーには複数のファイルが含まれます。test.cファイルには、システムライブラリーから次のものが含まれます。-

サンプルコードの

printk()機能には、linux/kernel.hヘッダーファイルが必要です。 -

linux/module.hファイルには、C 言語で記述した複数のソースファイルで共有する関数宣言とマクロ定義が含まれています。

-

サンプルコードの

-

次に、

init_module()関数およびcleanup_module()関数に従い、テキストを出力するカーネルロギング機能printk()を起動および終了します。 以下の内容で

/root/testmodule/Makefileを作成します。obj-m := test.o

Makefile には、コンパイラーが、

test.oという名前のオブジェクトファイルを作成する必要がある指示が含まれています。obj-mディレクティブは、生成されるtest.koファイルを、読み込み可能なカーネルモジュールとしてコンパイルすることを指定します。もしくは、obj-yディレクティブは、組み込みカーネルモジュールとしてtest.koをビルドするように指示します。カーネルモジュールをコンパイルします。

# make -C /lib/modules/$(uname -r)/build M=/root/testmodule modules make: Entering directory '/usr/src/kernels/4.18.0-305.el8.x86_64' CC [M] /root/testmodule/test.o Building modules, stage 2. MODPOST 1 modules WARNING: modpost: missing MODULE_LICENSE() in /root/testmodule/test.o see include/linux/module.h for more information CC /root/testmodule/test.mod.o LD [M] /root/testmodule/test.ko make: Leaving directory '/usr/src/kernels/4.18.0-305.el8.x86_64'コンパイラーは、各ソースファイル (

test.c) のオブジェクトファイル (test.o) を中間手順として作成してから、それらを最終カーネルモジュール (test.ko) にリンクします。コンパイルが成功すると、

/root/testmodule/には、コンパイル済みカスタムカーネルモジュールに関連する追加ファイルが含まれます。コンパイル済みモジュール自身は、test.koファイルで表されます。

検証

必要に応じて、

/root/testmodule/ディレクトリーのコンテンツを確認します。# ls -l /root/testmodule/ total 152 -rw-r—r--. 1 root root 16 Jul 26 08:19 Makefile -rw-r—r--. 1 root root 25 Jul 26 08:20 modules.order -rw-r—r--. 1 root root 0 Jul 26 08:20 Module.symvers -rw-r—r--. 1 root root 224 Jul 26 08:18 test.c -rw-r—r--. 1 root root 62176 Jul 26 08:20 test.ko -rw-r—r--. 1 root root 25 Jul 26 08:20 test.mod -rw-r—r--. 1 root root 849 Jul 26 08:20 test.mod.c -rw-r—r--. 1 root root 50936 Jul 26 08:20 test.mod.o -rw-r—r--. 1 root root 12912 Jul 26 08:20 test.oカーネルモジュールを

/lib/modules/$(uname -r)/ディレクトリーにコピーします。# cp /root/testmodule/test.ko /lib/modules/$(uname -r)/モジュールの依存関係のリストを更新します。

# depmod -aカーネルモジュールを読み込みます。

# modprobe -v test insmod /lib/modules/4.18.0-305.el8.x86_64/test.ko

カーネルモジュールが正常に読み込まれたことを確認します。

# lsmod | grep test test 16384 0カーネルリングバッファーから最新のメッセージを読み込みます。

# dmesg [74422.545004] Hello World This is a test

関連情報

第3章 セキュアブート用のカーネルとモジュールの署名

署名済みカーネルと署名済みカーネルモジュールを使用して、システムのセキュリティーを強化できます。セキュアブートが有効になっている UEFI ベースのビルドシステムでは、プライベートにビルドされたカーネルまたはカーネルモジュールに自己署名できます。さらに、カーネルまたはカーネルモジュールをデプロイするターゲットシステムに公開鍵をインポートすることもできます。

セキュアブートが有効な場合、次のすべてのコンポーネントを秘密鍵で署名し、対応する公開鍵で認証する必要があります。

- UEFI オペレーティングシステムのブートローダー

- Red Hat Enterprise Linux カーネル

- すべてのカーネルモジュール

これらのコンポーネントのいずれかが署名および認証されていない場合、システムは起動プロセスを完了できません。

RHEL 8 には以下が含まれます。

- 署名済みブートローダー

- 署名済みカーネル

- 署名済みカーネルモジュール

また、署名された第 1 ステージのブートローダーと署名されたカーネルには、組み込み Red Hat 公開鍵が含まれています。これらの署名済み実行可能バイナリーと組み込みキーにより、RHEL 8 は、UEFI セキュアブートをサポートするシステム上の UEFI ファームウェアによって提供される Microsoft UEFI セキュアブート認証局キーでインストール、起動、および実行できます。

- セキュアブートのサポートは、すべての UEFI ベースのシステムに含まれるわけではありません。

- カーネルモジュールを構築、署名するビルドシステムは、UEFI セキュアブートを有効にする必要がなく、UEFI ベースのシステムである必要すらありません。

3.1. 前提条件

外部でビルドされたカーネルモジュールに署名できるようにするには、次のパッケージからユーティリティーをインストールします。

# yum install pesign openssl kernel-devel mokutil keyutils表3.1 必要なユーティリティー

ユーティリティー 提供するパッケージ 使用対象 目的 efikeygenpesignビルドシステム

公開および秘密 X.509 鍵のペアを生成

opensslopensslビルドシステム

暗号化されていない秘密鍵をエクスポートします。

sign-filekernel-develビルドシステム

秘密鍵でカーネルモジュールに署名するために使用する実行ファイル

mokutilmokutilターゲットシステム

公開鍵を手動で登録する際に使用するオプションのユーティリティー

keyctlkeyutilsターゲットシステム

システムキーリングへの公開鍵の表示時に使用するオプションのユーティリティー

3.2. UEFI セキュアブートとは

Unified Extensible Firmware Interface (UEFI) セキュアブートテクノロジーを使用すると、信頼できる鍵によって署名されていないカーネル空間コードの実行を防ぐことができます。システムブートローダーは暗号鍵で署名されています。ファームウェアに含まれる公開鍵のデータベースは、署名鍵を承認します。その後、次のステージのブートローダーとカーネルで署名を検証できます。

UEFI セキュアブートは、以下のようにファームウェアから署名済みドライバーおよびカーネルモジュールへの信頼チェーンを確立します。

-

UEFI 秘密鍵が

shim第 1 ステージブートローダーに署名し、それを公開鍵が認証します。認証局 (CA) は公開鍵に署名します。CA はファームウェアのデータベースに保存されます。 -

shimファイルには、GRUB ブートローダーとカーネルを認証するための Red Hat 公開鍵 Red Hat Secure Boot (CA key 1) が含まれています。 - カーネルには、ドライバーおよびモジュールを認証する公開鍵が含まれます。

セキュアブートは、UEFI 仕様のブートパス検証コンポーネントです。この仕様は、以下を定義します。

- 揮発性ではないストレージでの暗号で保護された UEFI 変数用のプログラミングインターフェイス

- UEFI 変数での信頼できる X.509 ルート証明書の保存

- ブートローダーやドライバーなどの UEFI アプリケーションの検証

- 既知の問題のある証明書およびアプリケーションハッシュを無効にする手順

UEFI セキュアブートは、不正な変更の検出には役立ちますが、以下を行うことは できません。

- 第 2 ステージブートローダーのインストールまたは削除を防止する。

- このような変更について、ユーザーによる明示的な確認を要求する。

- ブートパスの操作を停止する。署名は、ブートローダーのインストールや更新時ではなく、起動時に検証されます。

ブートローダーまたはカーネルがシステムの信頼された鍵で署名されていない場合、セキュアブートにより起動が妨げられます。

3.3. UEFI セキュアブートのサポート

カーネルとロードされたすべてのドライバーが信頼できるキーで署名されている場合、UEFI セキュアブートが有効になっているシステムに RHEL 8 をインストールして実行できます。Red Hat は、関連する Red Hat キーによって署名および認証されたカーネルとドライバーを提供します。

外部でビルドされたカーネルまたはドライバーをロードする場合は、それらにも署名する必要があります。

UEFI セキュアブートによる制限

- システムは、署名が適切に認証された後にのみ、カーネルモードコードを実行します。

- GRUB モジュールの署名および検証を行うインフラストラクチャーがないため、GRUB モジュールの読み込みは無効です。モジュールの読み込みを許可すると、セキュアブートが定義するセキュリティー境界内で信頼できないコードが実行されることになります。

- Red Hat は、RHEL 8 でサポートされるすべてのモジュールが含まれる署名済み GRUB バイナリーを提供します。

関連情報

3.4. X.509 鍵でカーネルモジュールを認証するための要件

RHEL 8 では、カーネルモジュールがロードされると、カーネルはカーネルシステムキーリング (.builtin_trusted_keys) およびカーネルプラットフォームキーリング (.platform) からの公開 X.509 キーに対してモジュールの署名をチェックします。.platform キーリングには、サードパーティーのプラットフォームプロバイダーおよびカスタム公開鍵からのキーが含まれます。カーネルシステムの .blacklist キーリングからの鍵は検証から除外されます。

UEFI セキュアブート機能が有効になっているシステムでカーネルモジュールをロードするには、特定の条件を満たす必要があります。

UEFI セキュアブートが有効な場合、または

module.sig_enforceカーネルパラメーターが指定されている場合:-

署名がシステムキーリング (

.builtin_trusted_keys) およびプラットフォームキーリング (.platform) からの鍵に対して認証されている署名済みのカーネルモジュールだけを読み込みできます。 -

公開鍵は、システムで拒否されたキーのキーリング (

.blacklist) に配置できません。

-

署名がシステムキーリング (

UEFI セキュアブートが無効で

module.sig_enforceカーネルパラメーターが指定されていない場合:- 公開鍵なしで、未署名のカーネルモジュールと署名済みカーネルモジュールを読み込むことができます。

システムが UEFI ベースでない場合、または UEFI セキュアブートが無効になっている場合:

-

カーネルに埋め込まれた鍵のみが

.builtin_trusted_keysおよび.platformに読み込まれます。 - カーネルの再構築なしでキーセットを拡張することはできません。

-

カーネルに埋め込まれた鍵のみが

表3.2 カーネルモジュールの読み込み認証要件

| モジュールの署名 | 公開鍵ありおよび署名が有効 | UEFI セキュアブートの状態 | sig_enforce | モジュールの読み込み | カーネルのテイント |

|---|---|---|---|---|---|

| 署名なし | - | 有効でない | 有効でない | 成功 | はい |

| 有効でない | 有効 | 失敗 | - | ||

| 有効 | - | 失敗 | - | ||

| 署名あり | いいえ | 有効でない | 有効でない | 成功 | はい |

| 有効でない | 有効 | 失敗 | - | ||

| 有効 | - | 失敗 | - | ||

| 署名あり | はい | 有効でない | 有効でない | 成功 | いいえ |

| 有効でない | 有効 | 成功 | いいえ | ||

| 有効 | - | 成功 | いいえ |

3.5. 公開鍵のソース

カーネルは、起動時に X.509 キーを永続キーストアから以下のキーリングに読み込みます。

-

システムキーリング (

.builtin_trusted_keys) -

.platformキーリング -

システムの

.blacklistキーリング

表3.3 システムキーリングのソース

| X.509 鍵のソース | ユーザーによるキーの追加 | UEFI セキュアブートの状態 | ブート中に読み込まれる鍵 |

|---|---|---|---|

| カーネルに埋め込み | いいえ | - |

|

|

UEFI | 限定的 | 有効でない | いいえ |

| 有効 |

| ||

|

| いいえ | 有効でない | いいえ |

| 有効 |

| ||

| Machine Owner Key (MOK) リスト | はい | 有効でない | いいえ |

| 有効 |

|

.builtin_trusted_keys- 起動時にビルドされるキーリング

- 信頼できる公開鍵が含まれています。

-

鍵を表示するには

root権限が必要

.platform- 起動時にビルドされるキーリング

- サードパーティーのプラットフォームプロバイダーからのキーとカスタムの公開鍵が含まれています。

-

鍵を表示するには

root権限が必要

.blacklist- 失効した X.509 キーを含むキーリング

-

公開鍵が

.builtin_trusted_keysにある場合でも、.blacklistからのキーで署名されたモジュールは認証に失敗します。

- UEFI セキュアブート

db - 署名データベース

- UEFI アプリケーション、UEFI ドライバー、およびブートローダーのキー (ハッシュ) を保存します。

- キーはマシンにロードできます。

- UEFI セキュアブート

dbx - 失効した署名データベース

- キーが読み込まれないようにします。

-

このデータベースからの失効したキーは、

.blacklistキーリングに追加されます。

3.6. 公開鍵と秘密鍵の生成

セキュアブート対応システムでカスタムカーネルまたはカスタムカーネルモジュールを使用するには、X.509 の公開鍵と秘密鍵のペアを生成する必要があります。生成された秘密鍵を使用して、カーネルまたはカーネルモジュールに署名できます。また、対応する公開鍵をセキュアブートの Machine Owner Key (MOK) に追加することで、署名済みのカーネルまたはカーネルモジュールを検証できます。

強力なセキュリティー対策とアクセスポリシーを適用して、秘密鍵の内容を保護します。悪用すれば、この鍵は、一致する公開鍵で認証されるシステムのセキュリティーに危害を与えるために使用できます。

手順

X.509 の公開鍵と秘密鍵のペアを作成します。

カスタムカーネル モジュール に署名するだけの場合:

# efikeygen --dbdir /etc/pki/pesign \ --self-sign \ --module \ --common-name 'CN=Organization signing key' \ --nickname 'Custom Secure Boot key'

カスタム カーネル に署名する場合:

# efikeygen --dbdir /etc/pki/pesign \ --self-sign \ --kernel \ --common-name 'CN=Organization signing key' \ --nickname 'Custom Secure Boot key'

RHEL システムが FIPS モードを実行している場合:

# efikeygen --dbdir /etc/pki/pesign \ --self-sign \ --kernel \ --common-name 'CN=Organization signing key' \ --nickname 'Custom Secure Boot key' --token 'NSS FIPS 140-2 Certificate DB'

注記FIPS モードでは、

efikeygen がPKI データベース内でデフォルトの NSS Certificate DB トークンを検索できるように、--tokenオプションを使用する必要があります。公開鍵と秘密鍵は

/etc/pki/pesign/ディレクトリーに保存されます。

セキュリティー上、署名鍵の有効期間内にカーネルとカーネルモジュールに署名することが推奨されます。ただし、sign-file ユーティリティーは警告を表示せず、キーは有効期限に関係なく RHEL 8 で使用できます。

関連情報

-

openssl(1)の man ページ - RHEL Security Guide

- 公開鍵を MOK リストに追加することでターゲットシステムで公開鍵を登録する手順

3.7. システムキーリングの出力例

keyutils パッケージからの keyctl ユーティリティーを使用して、システムのキーリングの鍵に関する情報を表示できます。

前提条件

- root 権限がある。

-

keyutilsパッケージからkeyctlユーティリティーをインストールしました。

例3.1 キーリング出力

以下は、UEFI セキュアブートが有効になっている RHEL 8 システムからの .builtin_trusted_keys、.platform、および .blacklist キーリングの短縮された出力例です。

# keyctl list %:.builtin_trusted_keys 6 keys in keyring: ...asymmetric: Red Hat Enterprise Linux Driver Update Program (key 3): bf57f3e87... ...asymmetric: Red Hat Secure Boot (CA key 1): 4016841644ce3a810408050766e8f8a29... ...asymmetric: Microsoft Corporation UEFI CA 2011: 13adbf4309bd82709c8cd54f316ed... ...asymmetric: Microsoft Windows Production PCA 2011: a92902398e16c49778cd90f99e... ...asymmetric: Red Hat Enterprise Linux kernel signing key: 4249689eefc77e95880b... ...asymmetric: Red Hat Enterprise Linux kpatch signing key: 4d38fd864ebe18c5f0b7... # keyctl list %:.platform 4 keys in keyring: ...asymmetric: VMware, Inc.: 4ad8da0472073... ...asymmetric: Red Hat Secure Boot CA 5: cc6fafe72... ...asymmetric: Microsoft Windows Production PCA 2011: a929f298e1... ...asymmetric: Microsoft Corporation UEFI CA 2011: 13adbf4e0bd82... # keyctl list %:.blacklist 4 keys in keyring: ...blacklist: bin:f5ff83a... ...blacklist: bin:0dfdbec... ...blacklist: bin:38f1d22... ...blacklist: bin:51f831f...

この例の .builtin_trusted_keys キーリングは、UEFI セキュアブート db キーからの 2 つのキー、および shim ブートローダーに組み込まれている Red Hat Secure Boot (CA key 1) の追加を表しています。

例3.2 カーネルコンソール出力

以下の例は、カーネルコンソールの出力を示しています。このメッセージでは、UEFI セキュアブートに関連するソースの鍵を特定します。これらには、UEFI セキュアブート db、組み込みの shim、および MOK リストが含まれます。

# dmesg | egrep 'integrity.*cert'

[1.512966] integrity: Loading X.509 certificate: UEFI:db

[1.513027] integrity: Loaded X.509 cert 'Microsoft Windows Production PCA 2011: a929023...

[1.513028] integrity: Loading X.509 certificate: UEFI:db

[1.513057] integrity: Loaded X.509 cert 'Microsoft Corporation UEFI CA 2011: 13adbf4309...

[1.513298] integrity: Loading X.509 certificate: UEFI:MokListRT (MOKvar table)

[1.513549] integrity: Loaded X.509 cert 'Red Hat Secure Boot CA 5: cc6fa5e72868ba494e93...関連情報

-

keyctl(1)、dmesg(1)の man ページ

3.8. 公開鍵を MOK リストに追加することでターゲットシステムで公開鍵を登録する手順

カーネルまたはカーネルモジュールを認証およびロードするすべてのシステムに、公開鍵を登録する必要があります。さまざまな方法でターゲットシステムに公開鍵をインポートして、プラットフォームキーリング (.platform) が公開鍵を使用してカーネルまたはカーネルモジュールを認証できるようにすることができます。

セキュアブートが有効になっている UEFI ベースのシステムで RHEL 8 が起動すると、カーネルはセキュアブート db キーデータベースにあるすべての公開鍵をプラットフォームキーリング (.platform) にロードします。同時に、カーネルは失効したキーの dbx データベース内のキーを除外します。

Machine Owner Key (MOK) 機能を使用して、UEFI セキュアブートキーデータベースを拡張できます。セキュアブートが有効な UEFI 対応システムで RHEL 8 が起動すると、キーデータベースの鍵に加えて、MOK リストの鍵もプラットフォームキーリング (.platform) に追加されます。MOK リストの鍵は、セキュアブートデータベースの鍵と同様に永続的かつ安全な方法で保存されますが、これらは別個の機能です。MOK 機能は、shim、MokManager、GRUB、および mokutil ユーティリティーでサポートされています。

システムでカーネルモジュールの認証を実現するために、ファクトリーファームウェアイメージで公開鍵を UEFI セキュアブート鍵データベースに組み入れるようシステムベンダーに要求することを検討します。

前提条件

- 公開鍵と秘密鍵のペアを生成し、公開鍵の有効期限を知っています。詳細については、公開鍵と秘密鍵のペアの生成 を参照してください。

手順

公開鍵を

sb_cert.cerファイルにエクスポートします。# certutil -d /etc/pki/pesign \ -n 'Custom Secure Boot key' \ -Lr \ > sb_cert.cer

公開鍵を MOK リストにインポートします。

# mokutil --import sb_cert.cer- この MOK 登録要求の新しいパスワードを入力してください。

マシンを再起動します。

shimブートローダーは、保留中の MOK キー登録要求を認識し、MokManager.efiを起動して、UEFI コンソールから登録を完了できるようにします。Enroll MOKを選択し、プロンプトが表示されたら、この要求に関連付けたパスワードを入力し、登録を確認します。公開鍵が MOK リストに永続的に追加されます。

キーが MOK リストに追加されると、UEFI セキュアブートが有効になっている場合は、このブートおよび後続のブートで

.platformキーリングに自動的に伝達されます。

3.9. 秘密鍵でカーネルに署名する

UEFI セキュアブート機能が有効になっている場合は、署名済みカーネルをロードすると、システムのセキュリティーを強化できます。

前提条件

- 公開鍵と秘密鍵のペアを生成し、公開鍵の有効期限を知っています。詳細については、公開鍵と秘密鍵のペアの生成 を参照してください。

- ターゲットシステムに公開鍵を登録しています。詳細については、公開鍵を MOK リストに追加して、ターゲットシステムに公開鍵を登録する を参照してください。

- 署名に使用できる ELF 形式のカーネルイメージがあります。

手順

x64 アーキテクチャーの場合:

署名済みイメージを作成します。

# pesign --certificate 'Custom Secure Boot key' \ --in vmlinuz-version \ --sign \ --out vmlinuz-version.signed

versionをvmlinuzファイルのバージョン接尾辞に置き換え、Custom Secure Boot keyを以前に選択した名前に置き換えます。オプション: 署名を確認します。

# pesign --show-signature \ --in vmlinuz-version.signed

未署名イメージを署名済みイメージで上書きします。

# mv vmlinuz-version.signed vmlinuz-version

64 ビット ARM アーキテクチャーの場合:

vmlinuzファイルを解凍します。# zcat vmlinuz-version > vmlinux-version署名済みイメージを作成します。

# pesign --certificate 'Custom Secure Boot key' \ --in vmlinux-version \ --sign \ --out vmlinux-version.signed

オプション: 署名を確認します。

# pesign --show-signature \ --in vmlinux-version.signed

vmlinuxファイルを圧縮します。# gzip --to-stdout vmlinux-version.signed > vmlinuz-version圧縮されていない

vmlinuxファイルを削除します。# rm vmlinux-version*

3.10. 秘密鍵で GRUB ビルドに署名する

UEFI セキュアブート機能が有効になっているシステムでは、カスタムの既存の秘密鍵で GRUB ビルドに署名できます。カスタム GRUB ビルドを使用している場合、またはシステムから Microsoft トラストアンカーを削除した場合は、これを行う必要があります。

前提条件

- 公開鍵と秘密鍵のペアを生成し、公開鍵の有効期限を知っています。詳細については、公開鍵と秘密鍵のペアの生成 を参照してください。

- ターゲットシステムに公開鍵を登録しています。詳細については、公開鍵を MOK リストに追加して、ターゲットシステムに公開鍵を登録する を参照してください。

- 署名に使用できる GRUB EFI バイナリーがあります。

手順

x64 アーキテクチャーの場合:

署名済み GRUB EFI バイナリーを作成します。

# pesign --in /boot/efi/EFI/redhat/grubx64.efi \ --out /boot/efi/EFI/redhat/grubx64.efi.signed \ --certificate 'Custom Secure Boot key' \ --sign

Custom Secure Boot keyを以前に選択した名前に置き換えます。オプション: 署名を確認します。

# pesign --in /boot/efi/EFI/redhat/grubx64.efi.signed \ --show-signature

署名されていないバイナリーを署名済みバイナリーで上書きします。

# mv /boot/efi/EFI/redhat/grubx64.efi.signed \ /boot/efi/EFI/redhat/grubx64.efi

64 ビット ARM アーキテクチャーの場合:

署名済み GRUB EFI バイナリーを作成します。

# pesign --in /boot/efi/EFI/redhat/grubaa64.efi \ --out /boot/efi/EFI/redhat/grubaa64.efi.signed \ --certificate 'Custom Secure Boot key' \ --sign

Custom Secure Boot keyを以前に選択した名前に置き換えます。オプション: 署名を確認します。

# pesign --in /boot/efi/EFI/redhat/grubaa64.efi.signed \ --show-signature

署名されていないバイナリーを署名済みバイナリーで上書きします。

# mv /boot/efi/EFI/redhat/grubaa64.efi.signed \ /boot/efi/EFI/redhat/grubaa64.efi

3.11. 秘密鍵を使用したカーネルモジュールの署名

UEFI セキュアブートメカニズムが有効になっている場合は、署名済みカーネルモジュールをロードすることでシステムのセキュリティーを強化できます。

署名済みカーネルモジュールは、UEFI セキュアブートが無効になっているシステムまたは非 UEFI システムでもロードできます。そのため、カーネルモジュールの署名済みバージョンと未署名バージョンの両方を提供する必要はありません。

前提条件

- 公開鍵と秘密鍵のペアを生成し、公開鍵の有効期限を知っています。詳細については、公開鍵と秘密鍵のペアの生成 を参照してください。

- ターゲットシステムに公開鍵を登録しています。詳細については、公開鍵を MOK リストに追加して、ターゲットシステムに公開鍵を登録する を参照してください。

- ELF イメージ形式で署名できるカーネルモジュールがある。

手順

公開鍵を

sb_cert.cerファイルにエクスポートします。# certutil -d /etc/pki/pesign \ -n 'Custom Secure Boot key' \ -Lr \ > sb_cert.cer

NSS データベースからキーを PKCS #12 ファイルとして抽出します。

# pk12util -o sb_cert.p12 \ -n 'Custom Secure Boot key' \ -d /etc/pki/pesign

- 前のコマンドでプロンプトが表示されたら、秘密鍵を暗号化する新しいパスワードを入力します。

暗号化されていない秘密鍵をエクスポートします。

# openssl pkcs12 \ -in sb_cert.p12 \ -out sb_cert.priv \ -nocerts \ -nodes

重要暗号化されていない秘密鍵は慎重に取り扱ってください。

カーネルモジュールに署名します。次のコマンドは、カーネルモジュールファイル内の ELF イメージに署名を直接追加します。

# /usr/src/kernels/$(uname -r)/scripts/sign-file \ sha256 \ sb_cert.priv \ sb_cert.cer \ my_module.ko

これでカーネルモジュールの読み込み準備が完了しました。

RHEL 8 では、キーペアの有効期限が重要です。キーの有効期限はありませんが、カーネルモジュールはその署名キーの有効期間内に署名する必要があります。sign-file ユーティリティーでは、これに関する警告は表示されません。たとえば、2019 でのみ有効な鍵を使用して、その鍵で 2019 で署名されたカーネルモジュールを認証できます。ただし、ユーザーはこの鍵を使用して 2020 でカーネルモジュールに署名することはできません。

検証

カーネルモジュールの署名に関する情報を表示します。

# modinfo my_module.ko | grep signer signer: Your Name Key

生成時に入力した名前が署名に記載されていることを確認します。

注記この追加された署名は ELF イメージセクションには含まれず、また ELF イメージの正式な一部ではありません。したがって、

readelfなどのユーティリティーは、カーネルモジュールの署名を表示できません。モジュールをロードします。

# insmod my_module.koモジュールを削除 (アンロード) します。

# modprobe -r my_module.ko

関連情報

3.12. 署名済みカーネルモジュールの読み込み

公開鍵がシステムキーリング (.builtin_trusted_keys) と MOK リストに登録され、秘密鍵でそれぞれのカーネルモジュールに署名した後、modprobe コマンドで署名済みのカーネルモジュールをロードできます。

前提条件

- 公開鍵と秘密鍵のペアを生成しました。詳細については、公開鍵と秘密鍵のペアの生成 を参照してください。

- 公開鍵をシステムのキーリングに登録している。詳細については、公開鍵を MOK リストに追加して、ターゲットシステムに公開鍵を登録する を参照してください。

- 秘密鍵でカーネルモジュールに署名している。詳細については、秘密鍵を使用したカーネルモジュールの署名 を参照してください。

/lib/modules/$(uname -r)/extra/ディレクトリーを作成するkernel-modules-extraパッケージをインストールします。# yum -y install kernel-modules-extra

手順

公開鍵がシステムキーリング上にあることを確認します。

# keyctl list %:.platformカーネルモジュールを必要なカーネルの

extra/ディレクトリーにコピーします。# cp my_module.ko /lib/modules/$(uname -r)/extra/モジュールの依存関係のリストを更新します。

# depmod -aカーネルモジュールを読み込みます。

# modprobe -v my_module必要に応じて、起動時にモジュールをロードするには、モジュールを

/etc/modules-loaded.d/my_module.confファイルに追加します。# echo "my_module" > /etc/modules-load.d/my_module.conf

検証

モジュールが正常にロードされたことを確認します。

# lsmod | grep my_module

関連情報

第4章 カーネルコマンドラインパラメーターの設定

カーネルコマンドラインパラメーターを使用すると、ブート時に Red Hat Enterprise Linux カーネルの特定の側面の動作を変更できます。システム管理者は、システムの起動時に設定されるオプションを完全に制御できます。特定のカーネルの動作はシステムの起動時にのみ設定できるため、このような変更を行う方法を理解することが管理スキルの鍵となります。

カーネルコマンドラインパラメーターを変更してシステムの動作を変更すると、システムに悪影響が及ぶ可能性があります。変更を実稼働環境にデプロイする前に、必ず変更をテストしてください。詳細なガイダンスは、Red Hat サポートまでご連絡ください。

4.1. カーネルコマンドラインパラメーターの設定

カーネルコマンドラインパラメーターを使用すると、デフォルト値を上書きしたり、特定のハードウェア設定を指定したりできます。ブート時に、次の機能を設定できます。

- Red Hat Enterprise Linux カーネル

- 初期 RAM ディスク

- ユーザー領域機能

デフォルトでは、GRUB ブートローダーを使用するシステムのカーネルコマンドラインパラメーターは、カーネルブートエントリーごとに /boot/grub2/grubenv ファイルの kernelopts 変数で定義されます。

IBM Z では、zipl ブートローダーは環境変数に対応していないため、カーネルコマンドラインパラメーターはブートエントリー設定ファイルに保存されます。したがって、kernelopts 環境変数は使用できません。

grubby ユーティリティーを使用すると、ブートローダー設定ファイルを操作できます。grubby を使用すると、次のアクションを実行できます。

- デフォルトのブートエントリーの変更

- GRUB メニューエントリーに対する引数の追加または削除

関連情報

-

kernel-command-line(7)、bootparam(7)、およびdracut.cmdline (7)の man ページ - How to install and boot custom kernels in Red Hat Enterprise Linux 8

-

grubby(8)の man ページ

4.2. ブートエントリーについて

ブートエントリーは設定ファイルに格納され、特定のカーネルバージョンに関連付けられるオプションの集合です。実際には、ブートエントリーは、システムにカーネルがインストールされているのと同じ数だけあります。ブートエントリーの設定ファイルは、/boot/loader/entries/ ディレクトリーにあり、以下のようになります。

6f9cc9cb7d7845d49698c9537337cedc-4.18.0-5.el8.x86_64.conf

上記のファイル名は、/etc/machine-id ファイルに保存されているマシン ID と、カーネルバージョンから設定されます。

ブートエントリーの設定ファイルには、カーネルバージョン、初期 ramdisk イメージ、および kernelopts 環境変数 (カーネルコマンドラインパラメーターを含む) に関する情報が含まれます。ブートエントリー設定例の内容は、以下のようになります。

title Red Hat Enterprise Linux (4.18.0-74.el8.x86_64) 8.0 (Ootpa) version 4.18.0-74.el8.x86_64 linux /vmlinuz-4.18.0-74.el8.x86_64 initrd /initramfs-4.18.0-74.el8.x86_64.img $tuned_initrd options $kernelopts $tuned_params id rhel-20190227183418-4.18.0-74.el8.x86_64 grub_users $grub_users grub_arg --unrestricted grub_class kernel

kernelopts 環境変数は /boot/grub2/grubenv ファイルで定義されます。

4.3. すべてのブートエントリーでカーネルコマンドラインパラメーターの変更

システム上のすべてのブートエントリーのカーネルコマンドラインパラメーターを変更します。

前提条件

-

grubbyユーティリティーがシステムにインストールされていることを確認してください。 -

ziplユーティリティーが IBM Z システムにインストールされていることを確認してください。

手順

パラメーターを追加するには、以下を行います。

# grubby --update-kernel=ALL --args="<NEW_PARAMETER>"GRUB ブートローダーを使用するシステムの場合は、

/boot/grub2/grubenvのkernelopts変数に新しいカーネルパラメーターを追加して、ファイルを更新します。IBM Z で、ブートメニューを更新します。

# zipl

パラメーターを削除するには、次のコマンドを実行します。

# grubby --update-kernel=ALL --remove-args="<PARAMETER_TO_REMOVE>"IBM Z で、ブートメニューを更新します。

# zipl

新しくインストールされたカーネルは、以前に設定されたカーネルからカーネルコマンドラインパラメーターを継承します。

関連情報

- カーネルコマンドラインパラメーターの設定

-

grubby(8)およびzipl(8)の man ページ - grubby ツール

4.4. 1 つのブートエントリーでカーネルコマンドラインパラメーターの変更

システム上の単一のブートエントリーのカーネルコマンドラインパラメーターを変更します。

前提条件

-

grubbyユーティリティーおよびziplユーティリティーがシステムにインストールされている。

手順

パラメーターを追加するには、以下を行います。

# grubby --update-kernel=/boot/vmlinuz-$(uname -r) --args="<NEW_PARAMETER>"IBM Z で、ブートメニューを更新します。

# zipl

パラメーターを削除するには、次のコマンドを実行します。

# grubby --update-kernel=/boot/vmlinuz-$(uname -r) --remove-args="<PARAMETER_TO_REMOVE>"IBM Z で、ブートメニューを更新します。

# zipl

grub.cfg ファイルを使用するシステムでは、デフォルトで、カーネルブートエントリーごとに options パラメーターがあり、これは kernelopts 変数に設定されます。この変数は、/boot/grub2/grubenv 設定ファイルで定義されます。

GRUB2 システムの場合:

-

すべてのブートエントリーに対してカーネルコマンドラインパラメーターを変更する場合には、

grubbyユーティリティーは/boot/grub2/grubenvファイルのkernelopts変数を更新します。 -

1 つのブートエントリーのカーネルコマンドラインパラメーターが変更されると、

kernelopts変数の拡張やカーネルパラメーターの変更が行われ、得られた値は各ブートエントリーの/boot/loader/entries/<RELEVANT_KERNEL_BOOT_ENTRY.conf>ファイルに保存されます。

zIPL システムの場合:

-

grubbyは、個別のカーネルブートエントリーのカーネルコマンドラインパラメーターを変更して、/boot/loader/entries/<ENTRY>.confファイルに保存します。

関連情報

- カーネルコマンドラインパラメーターの設定

-

grubby(8)およびzipl(8)の man ページ - grubby ツール

4.5. 起動時の一時的なカーネルコマンドラインパラメーターの変更

1 回の起動プロセス中にのみカーネルパラメーターを変更することで、カーネルメニューエントリーを一時的に変更します。

この手順は単一ブートにのみ適用され、変更は永続的に行われません。

手順

- GRUB 2 ブートメニューを起動します。

- 起動するカーネルを選択します。

- e キーを押してカーネルパラメーターを編集します。

-

カーソルを下に移動してカーネルコマンドラインを見つけます。カーネルコマンドラインは、64 ビット IBM Power シリーズおよび x86-64 BIOS ベースのシステムの場合は

linuxで始まり、UEFI システムの場合はlinuxefiで始まります。 カーソルを行の最後に移動します。

注記行の最初に移動するには Ctrl+a を押します。行の最後に移動するには Ctrl+e を押します。システムによっては、Home キーおよび End キーも機能する場合があります。

必要に応じてカーネルパラメーターを編集します。たとえば、緊急モードでシステムを実行するには、

linux行の最後にemergencyパラメーターを追加します。linux ($root)/vmlinuz-4.18.0-348.12.2.el8_5.x86_64 root=/dev/mapper/rhel-root ro crashkernel=auto resume=/dev/mapper/rhel-swap rd.lvm.lv=rhel/root rd.lvm.lv=rhel/swap rhgb quiet emergencyシステムメッセージを有効にするには、

rhgbおよびquietパラメーターを削除します。- Ctrl+x を押して、選択したカーネルと変更したコマンドラインパラメーターで起動します。

Esc キーを押してコマンドラインの編集を終了すると、ユーザーの加えた変更はすべて破棄されます。

4.6. シリアルコンソール接続を有効にする GRUB 設定

シリアルコンソールは、ネットワークがダウンしている場合にヘッドレスサーバーまたは埋め込みシステムに接続する際に便利です。あるいは、セキュリティールールを回避し、別のシステムへのログインアクセスを取得する必要がある場合などです。

シリアルコンソール接続を使用するように、デフォルトの GRUB 設定の一部を設定する必要があります。

前提条件

- root 権限がある。

手順

/etc/default/grubファイルに以下の 2 つの行を追加します。GRUB_TERMINAL="serial" GRUB_SERIAL_COMMAND="serial --speed=9600 --unit=0 --word=8 --parity=no --stop=1"

最初の行は、グラフィカルターミナルを無効にします。

GRUB_TERMINALキーは、GRUB_TERMINAL_INPUTおよびGRUB_TERMINAL_OUTPUTの値を上書きします。2 行目は、ボーレート (

--speed)、パリティー、および他の値を使用中の環境とハードウェアに適合するように調整します。以下のログファイルのようなタスクには、115200 のように非常に高いボーレートが推奨されます。GRUB 設定ファイルを更新します。

BIOS ベースのマシンの場合:

# grub2-mkconfig -o /boot/grub2/grub.cfgUEFI ベースのマシンの場合:

# grub2-mkconfig -o /boot/efi/EFI/redhat/grub.cfg

- システムを再起動して、変更を有効にします。

第5章 ランタイム時のカーネルパラメーターの設定

システム管理者は、ランタイム時に Red Hat Enterprise Linux カーネルの動作を多数変更できます。sysctl コマンドを使用し、/etc/sysctl.d/ および /proc/sys/ ディレクトリー内の設定ファイルを変更して、実行時にカーネルパラメーターを設定します。

プロダクションシステムでカーネルパラメーターを設定するには、慎重なプランニングが必要です。プランニングが欠如した変更では、カーネルが不安定になり、システムの再起動が必要とることがあります。カーネル値を変更する前に、有効なオプションを使用していることを確認してください。

5.1. カーネルパラメーターとは

カーネルパラメーターは、システムの実行中に調整できる調整可能な値です。変更を有効にする場合でも、カーネルの再起動や再コンパイルは不要です。

以下を使用してカーネルパラメーターに対応できます。

-

sysctlコマンド -

/proc/sys/ディレクトリーにマウントされている仮想ファイルシステム -

/etc/sysctl.d/ディレクトリー内の設定ファイル

調整可能パラメーターは、カーネルサブシステムでクラスに分割されます。Red Hat Enterprise Linux には、以下の調整可能のクラスがあります。

表5.1 sysctl クラスの表

| 調整パラメーターのクラス | サブシステム |

|---|---|

|

| 実行ドメインおよびパーソナリティー |

|

| 暗号化インターフェイス |

|

| カーネルのデバッグインターフェイス |

|

| デバイス固有の情報 |

|

| グローバルおよび固有の調整可能なファイルシステム |

|

| グローバルなカーネルの設定項目 |

|

| ネットワークの設定項目 |

|

| Sun Remote Procedure Call (NFS) |

|

| ユーザー名前空間の制限 |

|

| メモリー、バッファー、およびキャッシュのチューニングと管理 |

関連情報

-

sysctl(8)およびsysctl.d(5)の man ページ

5.2. sysctl でカーネルパラメーターの一時的な設定

sysctl コマンドを使用して、実行時に一時的にカーネルパラメーターを設定します。このコマンドは、調整可能パラメーターのリスト表示およびフィルタリングにも便利です。

前提条件

- root 権限がある。

手順

すべてのパラメーターとその値をリストします。

# sysctl -a注記# sysctl -aコマンドは、ランタイム時およびシステムの起動時に調整できるカーネルパラメーターを表示します。パラメーターを一時的に設定するには、次のように入力します。

# sysctl <TUNABLE_CLASS>.<PARAMETER>=<TARGET_VALUE>上記のサンプルコマンドは、システムの実行中にパラメーター値を変更します。この変更は、再起動なしですぐに適用されます。

注記変更は、システムの再起動後にデフォルトに戻ります。

関連情報

-

sysctl(8)の man ページ - sysctl を使用したカーネルパラメーターの永続的な設定

- /etc/sysctl.d/ の設定ファイルでカーネルパラメーターの調整

5.3. sysctl を使用したカーネルパラメーターの永続的な設定

sysctl コマンドを使用して、カーネルパラメーターを永続的に設定します。

前提条件

- root 権限がある。

手順

すべてのパラメーターをリストします。

# sysctl -aこのコマンドは、ランタイム時に設定できるカーネルパラメーターをすべて表示します。

パラメーターを永続的に設定すします。

# sysctl -w <TUNABLE_CLASS>.<PARAMETER>=<TARGET_VALUE> >> /etc/sysctl.confサンプルコマンドは、調整可能な値を変更して、

/etc/sysctl.confファイルに書き込みます。これにより、カーネルパラメーターのデフォルト値が上書きされます。変更は、再起動なしで即座に永続的に反映されます。

カーネルパラメーターを永続的に変更するには、/etc/sysctl.d/ ディレクトリーの設定ファイルに手動で変更を行ってください。

関連情報

-

sysctl(8)およびsysctl.conf(5)の man ページ - /etc/sysctl.d/ の設定ファイルでカーネルパラメーターの調整

5.4. /etc/sysctl.d/ の設定ファイルでカーネルパラメーターの調整

/etc/sysctl.d/ ディレクトリーの設定ファイルを手動で変更して、カーネルパラメーターを永続的に設定します。

前提条件

- root 権限がある。

手順

/etc/sysctl.d/に新しい設定ファイルを作成します。# vim /etc/sysctl.d/<some_file.conf>カーネルパラメーターを 1 行に 1 つずつ含めます。

<TUNABLE_CLASS>.<PARAMETER>=<TARGET_VALUE><TUNABLE_CLASS>.<PARAMETER>=<TARGET_VALUE>- 設定ファイルを作成します。

マシンを再起動して、変更を有効にします。

また、再起動せずに変更を適用するには、以下を実行します。

# sysctl -p /etc/sysctl.d/<some_file.conf>このコマンドにより、以前に作成した設定ファイルから値を読み取ることができます。

関連情報

-

sysctl(8)、sysctl.d(5)の man ページ

5.5. /proc/sys/ でカーネルパラメーターの一時的な設定

/proc/sys/ 仮想ファイルシステムディレクトリー内のファイルを使用して、一時的にカーネルパラメーターを設定します。

前提条件

- root 権限がある。

手順

設定するカーネルパラメーターを特定します。

# ls -l /proc/sys/<TUNABLE_CLASS>/コマンドが返した書き込み可能なファイルは、カーネルの設定に使用できます。読み取り専用権限を持つユーザーは、現在の設定についてフィードバックを提供します。

カーネルパラメーターにターゲットの値を割り当てます。

# echo <TARGET_VALUE> > /proc/sys/<TUNABLE_CLASS>/<PARAMETER>このコマンドでは、システムが再起動すると設定変更が消えます。

必要に応じて、新しく設定した設定したカーネルパラメーターの値を確認します。

# cat /proc/sys/<TUNABLE_CLASS>/<PARAMETER>

5.6. 関連情報

第6章 GRUB メニューを一時的に変更する

GRUB メニューエントリーを変更したり、現在のブートにのみ適用される引数をカーネルに渡したりできます。ブートローダーメニューで選択したメニューエントリーでは、次のことができます。

- e キーを押して、メニューエントリーエディターインターフェイスを表示します。

- 変更を破棄し、Esc キーを押して標準メニューインターフェイスを再読み込みします。

- c キーを押してコマンドラインインターフェイスをロードします。

- 関連する GRUB コマンドを入力し、Enter キーを押して入力します。

- Tab キーを押して、コンテキストに基づいてコマンドを完了します。

- Ctrl+a キーの組み合わせを押して、行の先頭に移動します。

- Ctrl+e キーの組み合わせを押して、行末に移動します。

次の手順では、1 回の起動プロセス中に GRUB メニューを変更する方法について説明します。

6.1. GRUB について

GRUB は GNU GRand Unified Bootloader の略です。GRUB を使用すると、システムの起動時にロードするオペレーティングシステムまたはカーネルを選択できます。また、カーネルに引数を渡すこともできます。

GRUB で起動する場合は、メニューインターフェイスまたはコマンドラインインターフェイス (GRUB command shell) のいずれかを使用できます。システムを起動すると、メニューインターフェイスが表示されます。

c キーを押すと、コマンドラインインターフェイスに切り替えることができます。

exit と入力して Enter キーを押すと、メニューインターフェイスに戻ることができます。

GRUB BLS ファイル

ブートローダーメニューエントリーは、ブートローダー仕様 (BLS) ファイルとして定義されます。このファイル形式は、ブートローダー設定ファイルを操作することなく、ドロップインディレクトリー内の各ブートオプションのブートローダー設定を管理します。grubby ユーティリティーは、これらの BLS ファイルを編集できます。

GRUB 設定ファイル

/boot/grub2/grub.cfg 設定ファイルは、メニューエントリーを定義しません。

関連情報

6.2. ブートローダー仕様の概要

BootLoader Specification (BLS) は、ブートローダー設定ファイルを操作せずに、ドロップインディレクトリーの各起動オプションのブートローダー設定を管理するスキームとファイル形式を定義します。前述の方法とは異なり、各ブートエントリーはドロップインディレクトリーの個別の設定ファイルで表されるようになりました。ドロップインディレクトリーは、設定ファイルを編集または再生成せずに設定を拡張します。BLS は、ブートメニューエントリーのこの概念を拡張します。

BLS を使用すると、ディレクトリー内の個々のブートエントリーファイルを追加、削除、または編集して、ブートローダーメニューのオプションを管理できます。これにより、カーネルのインストールプロセスがはるかに簡素化され、異なるアーキテクチャーの間でこのプロセスの一貫性を保つことができます。

grubby ツールは、BLS に関するシンラッパースクリプトで、同じ grubby 引数およびオプションをサポートします。dracut を実行して、初期 ramdisk イメージを作成します。この設定では、コアブートローダーの設定ファイルは静的で、カーネルのインストール後に変更されません。

RHEL 8 では、同じブートローダーがすべてのアーキテクチャーで使用されているわけではないため、RHEL 8 には特に該当します。GRUB は、64 ビット ARM などのほとんどのアーキテクチャーに使用されますが、Open Power Abstraction Layer (OPAL) を使用する IBM Power Systems のリトルエンディアンバリアントは Petitboot を使用し、IBM Z アーキテクチャーは zipl を使用します。

関連情報

- 「ブートエントリーについて」

-

grubby(8)man ページ

6.3. レスキューモードでの起動

レスキューモードは、便利なシングルユーザー環境を提供し、通常の起動プロセスを完了できない状況においてシステムの修復を可能にします。レスキューモードでは、システムはすべてのローカルファイルシステムをマウントし、いくつかの重要なシステムサービスを開始しようとします。ただし、ネットワークインターフェイスをアクティブにしたり、より多くのユーザーが同時にシステムにログインしたりすることはできません。

手順

- GRUB ブート画面で、e キーを押して編集します。

Linux行の末尾に次のパラメーターを追加します。systemd.unit=rescue.target

Ctrl+x を押して、レスキューモードで起動します。

6.4. 緊急モードでの起動

緊急モードは、可能な限り最小限の環境を提供し、システムがレスキューモードに入れない状態でもシステムの修復を可能にします。

緊急モードでは、システムは次のことを行います。

-

rootファイルシステムを読み取り専用にマウントします - いくつかの重要なサービスを開始します

ただし、システムは次のことを 行いません。

- 他のローカルファイルシステムのマウントを試みる

- ネットワークインターフェイスをアクティブにする

手順

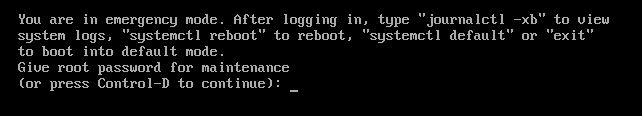

- GRUB ブート画面で、e キーを押して編集します。

Linux行の末尾に次のパラメーターを追加します。systemd.unit=emergency.target

Ctrl+x を押して緊急モードで起動します。

6.5. デバッグシェルのブート

systemd デバッグシェルは、起動プロセスの非常に早い段階でシェルを提供します。デバッグシェルに入ったら、systemctl list-jobs や systemctl list-units などの systemctl コマンドを使用して、systemd 関連の起動問題の原因を検索できます。

手順

- GRUB ブート画面で、e キーを押して編集します。

Linux行の末尾に次のパラメーターを追加します。systemd.debug-shell

必要に応じて、

デバッグオプションを追加します。注記カーネルコマンドラインに

debugオプションを追加すると、ログメッセージの数が増加します。systemdでは、カーネルコマンドラインオプションのdebugが、systemd.log_level=debugのショートカットになりました。- Ctrl+x を押して、デバッグシェルを起動します。

デバッグシェルを使用するには認証が必要ないため、デバッグシェルを永続的に有効にすることにはセキュリティー上のリスクがあります。デバッグシェルは、デバッグセッションが終了したときに無効にしてください。

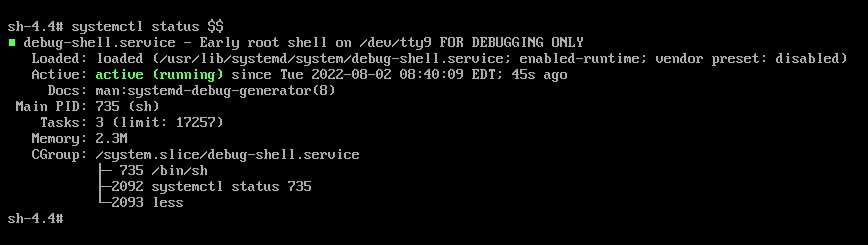

6.6. デバッグシェルへの接続

起動プロセス中に、systemd-debug-generator は TTY9 でデバッグシェルを設定します。

前提条件

- デバッグシェルが正常に起動しました。デバッグシェルのブート を参照してください。

手順

Ctrl+Alt+F9 を押してデバッグシェルに接続します。

仮想マシンを使用している場合は、このキーの組み合わせを送信するには、仮想化アプリケーションからのサポートが必要です。たとえば、Virtual Machine Manager を使用している場合は、メニューから Send Key →

Ctrl+Alt+F9を選択します。- デバッグシェルは認証を必要としないため、TTY9 で次のようなプロンプトが表示されます。

sh-4.4#

検証手順

以下のようなコマンドを入力します。

sh-4.4# systemctl status $$

- デフォルトのシェルに戻るには、ブートが成功した場合に Ctrl+Alt+F1 を押します。

関連情報

-

systemd-debug-generator(8)man ページ

6.7. インストールディスクを使用した root パスワードのリセット

root パスワードを忘れた場合や紛失した場合は、リセットできます。

手順

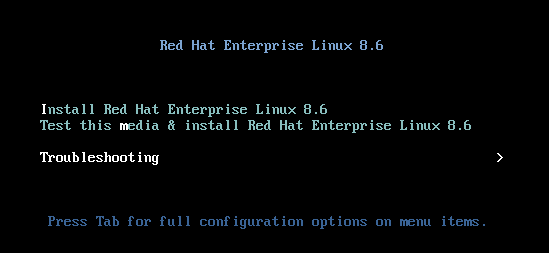

- インストールソースからホストを起動します。

インストールメディアのブートメニューで、

Troubleshootingを選択します。

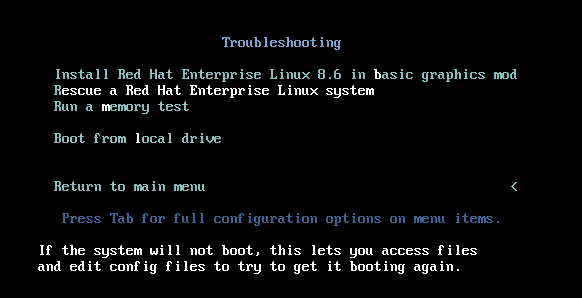

Troubleshooting メニューで

Rescue a Red Hat Enterprise Linux systemオプションを選択します。

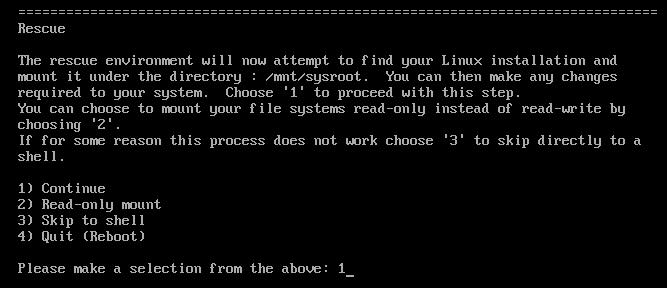

Rescue メニューで

1を選択し、Enter キーを押して続行します。

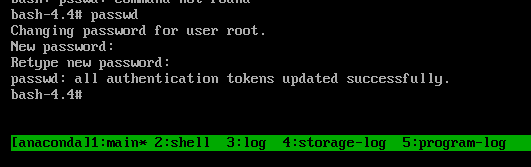

以下のようにファイルシステム

rootを変更します。sh-4.4# chroot /mnt/sysimage

passwdコマンドを入力し、コマンドラインに表示される指示にしたがってrootパスワードを変更します。

時間がかかるディスクの SELinux の再ラベルを防ぐために、

autorelableファイルを削除します。sh-4.4# rm -f /.autorelabel

-

exitコマンドを入力して、chroot環境を終了します。 -

exitコマンドを再び実行して初期化を再開し、システム起動を完了します。

6.8. rd.break を使用した root パスワードのリセット

root パスワードを忘れた場合や紛失した場合は、リセットできます。

手順

- システムを起動し、GRUB ブート画面で e キーを押して編集を行います。

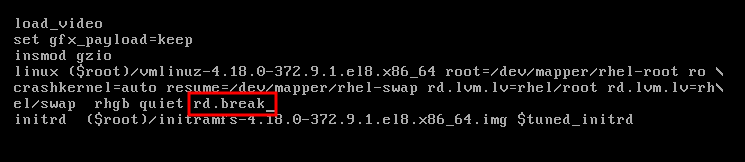

Linux行の末尾にrd.breakパラメーターを追加します。

Ctrl+x を押して変更したパラメーターでシステムを起動します。

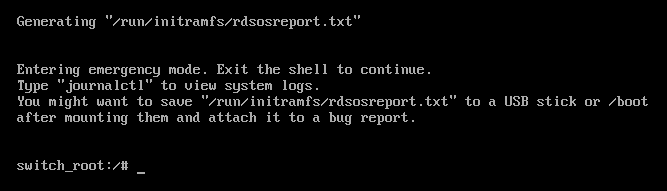

ファイルシステムを書き込み可能で再マウントします。

switch_root:/# mount -o remount,rw /sysrootファイルシステムの

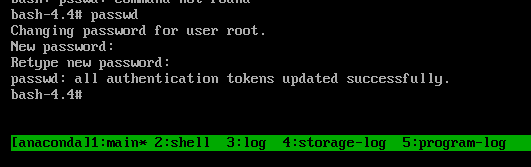

rootを変更します。switch_root:/# chroot /sysrootpasswdコマンドを入力し、コマンドラインに表示される指示に従います。

次回のシステム起動時にすべてのファイルにラベルを付け直します。

sh-4.4# touch /.autorelabelファイルシステムを 読み取り専用 で再マウントします。

sh-4.4# mount -o remount,ro /-

exitコマンドを入力して、chroot環境を終了します。 exitコマンドを再び実行して初期化を再開し、システム起動を完了します。注記SELinux の再ラベル付けプロセスには時間がかかる場合があります。プロセスが完了すると、システムが自動的に再起動します。

enforcing=0 オプションを追加すると、時間のかかる SELinux の再ラベル付けプロセスを省略できます。

手順

linux行の最後にrd.breakパラメーターを追加するときは、enforcing=0も追加します。rd.break enforcing=0

/etc/shadowファイルの SELinux セキュリティーコンテキストを復元します。# restorecon /etc/shadowSELinux ポリシーの適用をオンに戻し、オンになっていることを確認します。

# setenforce 1 # getenforce Enforcing

手順 3 で enforcing=0 オプションを追加した場合は、手順 8 で touch /.autorelabel コマンドの入力を省略できることに注意してください。

6.9. 関連情報

-

/usr/share/doc/grub2-commonディレクトリー。 -

info grub2コマンド。

第7章 GRUB ブートローダーに永続的な変更を加える

grubby ツールを使用して、GRUB で永続的な変更を行います。

7.1. 前提条件

- システムに RHEL が正常にインストールされました。

- root 権限がある。

7.2. デフォルトのカーネルの一覧表示

デフォルトのカーネルを一覧表示すると、デフォルトのカーネルのファイル名およびインデックス番号を見つけて、GRUB ブートローダーに永続的な変更を加えることができます。

手順

- デフォルトのカーネルのファイル名を確認するには、次のように入力します。

# grubby --default-kernel

/boot/vmlinuz-4.18.0-372.9.1.el8.x86_64- デフォルトのカーネルのインデックス番号を調べるには、次のように入力します。

# grubby --default-index

07.3. カーネルの GRUB メニューエントリーの表示

すべてのカーネルメニューエントリーを一覧表示するか、特定のカーネルの GRUB メニューエントリーを表示できます。

手順

すべてのカーネルメニューエントリーを一覧表示するには、次のように入力します。

# grubby --info=ALL index=0 kernel="/boot/vmlinuz-4.18.0-372.9.1.el8.x86_64" args="ro crashkernel=auto resume=/dev/mapper/rhel-swap rd.lvm.lv=rhel/root rd.lvm.lv=rhel/swap rhgb quiet $tuned_params zswap.enabled=1" root="/dev/mapper/rhel-root" initrd="/boot/initramfs-4.18.0-372.9.1.el8.x86_64.img $tuned_initrd" title="Red Hat Enterprise Linux (4.18.0-372.9.1.el8.x86_64) 8.6 (Ootpa)" id="67db13ba8cdb420794ef3ee0a8313205-4.18.0-372.9.1.el8.x86_64" index=1 kernel="/boot/vmlinuz-0-rescue-67db13ba8cdb420794ef3ee0a8313205" args="ro crashkernel=auto resume=/dev/mapper/rhel-swap rd.lvm.lv=rhel/root rd.lvm.lv=rhel/swap rhgb quiet" root="/dev/mapper/rhel-root" initrd="/boot/initramfs-0-rescue-67db13ba8cdb420794ef3ee0a8313205.img" title="Red Hat Enterprise Linux (0-rescue-67db13ba8cdb420794ef3ee0a8313205) 8.6 (Ootpa)" id="67db13ba8cdb420794ef3ee0a8313205-0-rescue"特定のカーネルの GRUB メニューエントリーを表示するには、次のように入力します。

# grubby --info /boot/vmlinuz-4.18.0-372.9.1.el8.x86_64 grubby --info /boot/vmlinuz-4.18.0-372.9.1.el8.x86_64 index=0 kernel="/boot/vmlinuz-4.18.0-372.9.1.el8.x86_64" args="ro crashkernel=auto resume=/dev/mapper/rhel-swap rd.lvm.lv=rhel/root rd.lvm.lv=rhel/swap rhgb quiet $tuned_params zswap.enabled=1" root="/dev/mapper/rhel-root" initrd="/boot/initramfs-4.18.0-372.9.1.el8.x86_64.img $tuned_initrd" title="Red Hat Enterprise Linux (4.18.0-372.9.1.el8.x86_64) 8.6 (Ootpa)" id="67db13ba8cdb420794ef3ee0a8313205-4.18.0-372.9.1.el8.x86_64"

タブ補完を試行して /boot ディレクトリー内の利用可能なカーネルを確認します。

7.4. カーネル引数の編集

既存のカーネル引数の値を変更できます。たとえば、仮想コンソール (画面) のフォントとサイズを変更できます。

手順

仮想コンソールのフォントを、サイズが

32のlatarcyrheb-sunに変更します。# grubby --args=vconsole.font=latarcyrheb-sun32 --update-kernel /boot/vmlinuz-4.18.0-372.9.1.el8.x86_64

7.5. GRUB メニューエントリーに対する引数の追加および削除

GRUB メニューから引数を追加、削除、または同時に追加および削除できます。

手順

GRUB メニューエントリーに引数を追加するには、

--update-kernelオプションを--argsと組み合わせて使用します。たとえば、次のコマンドはシリアルコンソールを追加します。# grubby --args=console=ttyS0,115200 --update-kernel /boot/vmlinuz-4.18.0-372.9.1.el8.x86_64コンソールの引数は行末に付けられ、新しいコンソールは他の設定済みコンソールよりも優先されます。

GRUB メニューエントリーから引数を削除するには、

--update-kernelオプションを--remove-argsと組み合わせて使用します。以下に例を示します。# grubby --remove-args="rhgb quiet" --update-kernel /boot/vmlinuz-4.18.0-372.9.1.el8.x86_64このコマンドは、Red Hat グラフィカルブート引数を削除し、詳細モードであるログメッセージを有効にします。

引数を同時に追加および削除するには、次のように入力します。

# grubby --remove-args="rhgb quiet" --args=console=ttyS0,115200 --update-kernel /boot/vmlinuz-4.18.0-372.9.1.el8.x86_64

検証手順

行った永続的な変更を確認するには、次のように入力します。

# grubby --info /boot/vmlinuz-4.18.0-372.9.1.el8.x86_64 index=0 kernel="/boot/vmlinuz-4.18.0-372.9.1.el8.x86_64" args="ro crashkernel=auto resume=/dev/mapper/rhel-swap rd.lvm.lv=rhel/root rd.lvm.lv=rhel/swap $tuned_params zswap.enabled=1 console=ttyS0,115200" root="/dev/mapper/rhel-root" initrd="/boot/initramfs-4.18.0-372.9.1.el8.x86_64.img $tuned_initrd" title="Red Hat Enterprise Linux (4.18.0-372.9.1.el8.x86_64) 8.6 (Ootpa)" id="67db13ba8cdb420794ef3ee0a8313205-4.18.0-372.9.1.el8.x86_64"

7.6. 新しいブートエントリーの追加

ブートローダーメニューエントリーに新しいブートエントリーを追加できます。

手順

すべてのカーネル引数をデフォルトカーネルからこの新しいカーネルエントリーにコピーします。

# grubby --add-kernel=new_kernel --title="entry_title" --initrd="new_initrd" --copy-default利用可能なブートエントリーの一覧を取得します。

# ls -l /boot/loader/entries/* -rw-r--r--. 1 root root 408 May 27 06:18 /boot/loader/entries/67db13ba8cdb420794ef3ee0a8313205-0-rescue.conf -rw-r--r--. 1 root root 536 Jun 30 07:53 /boot/loader/entries/67db13ba8cdb420794ef3ee0a8313205-4.18.0-372.9.1.el8.x86_64.conf -rw-r--r-- 1 root root 336 Aug 15 15:12 /boot/loader/entries/d88fa2c7ff574ae782ec8c4288de4e85-4.18.0-193.el8.x86_64.conf新たなブートエントリーを作成します。たとえば、4.18.0-193.el8.x86_64 カーネルの場合は、次のようにコマンドを発行します。

# grubby --grub2 --add-kernel=/boot/vmlinuz-4.18.0-193.el8.x86_64 --title="Red Hat Enterprise 8 Test" --initrd=/boot/initramfs-4.18.0-193.el8.x86_64.img --copy-default

検証

新しく追加されたブートエントリーが、使用可能なブートエントリーの一覧に表示されていることを確認します。

# ls -l /boot/loader/entries/* -rw-r--r--. 1 root root 408 May 27 06:18 /boot/loader/entries/67db13ba8cdb420794ef3ee0a8313205-0-rescue.conf -rw-r--r--. 1 root root 536 Jun 30 07:53 /boot/loader/entries/67db13ba8cdb420794ef3ee0a8313205-4.18.0-372.9.1.el8.x86_64.conf -rw-r--r-- 1 root root 287 Aug 16 15:17 /boot/loader/entries/d88fa2c7ff574ae782ec8c4288de4e85-4.18.0-193.el8.x86_64.0~custom.conf -rw-r--r-- 1 root root 287 Aug 16 15:29 /boot/loader/entries/d88fa2c7ff574ae782ec8c4288de4e85-4.18.0-193.el8.x86_64.conf

7.7. grubby でデフォルトのブートエントリーを変更する

grubby ツールを使用すると、デフォルトのブートエントリーを変更できます。

手順

- デフォルトのカーネルとして指定されたカーネルに永続的な変更を加えるには、次のように入力します。

# grubby --set-default /boot/vmlinuz-4.18.0-372.9.1.el8.x86_64

The default is /boot/loader/entries/67db13ba8cdb420794ef3ee0a8313205-4.18.0-372.9.1.el8.x86_64.conf with index 0 and kernel /boot/vmlinuz-4.18.0-372.9.1.el8.x86_647.8. 同じ引数を使用したすべてのカーネルメニューの更新

すべてのカーネルメニューエントリーに同じカーネルブート引数を追加できます。

手順

すべてのカーネルメニューエントリーに同じカーネルブート引数を追加するには、

--update-kernel=ALLパラメーターをアタッチします。たとえば、次のコマンドはシリアルコンソールをすべてのカーネルに追加します。# grubby --update-kernel=ALL --args=console=ttyS0,115200注記--update-kernelパラメーターには、DEFAULTまたはカーネルインデックス番号のコンマ区切りリストも指定できます。

7.9. 現在および将来のカーネルのデフォルトカーネルオプションの変更

kernelopts 変数を使用すると、現在および将来のカーネルのデフォルトカーネルオプションを変更できます。

手順

kernelopts変数を使用してカーネルパラメーターをリスト表示します。# grub2-editenv - list | grep kernelopts kernelopts=root=/dev/mapper/rhel-root ro crashkernel=auto resume=/dev/mapper/rhel-swap rd.lvm.lv=rhel/root rd.lvm.lv=rhel/swap rhgb quietカーネルのコマンドラインパラメーターを変更します。パラメーターを追加、削除、または変更できます。たとえば、

debugパラメーターを追加するには、次のように入力します。# grub2-editenv - set "$(grub2-editenv - list | grep kernelopts) <debug>"オプション: 新しく追加したパラメーターが

kerneloptsに追加されていることを確認します。# grub2-editenv - list | grep kernelopts kernelopts=root=/dev/mapper/rhel-root ro crashkernel=auto resume=/dev/mapper/rhel-swap rd.lvm.lv=rhel/root rd.lvm.lv=rhel/swap rhgb quiet debug

- システムを再起動して、変更を有効にします。

代わりに、grubby コマンドを使用して、現在および将来のカーネルに引数を渡すこともできます。

# grubby --update-kernel ALL --args="<PARAMETER>"7.10. 関連情報

-

/usr/share/doc/grub2-commonディレクトリー。 -

info grub2コマンド。

第8章 カスタマイズされたブートメニューの構築

特定のエントリーを含むブートメニューを作成したり、エントリーの順序を変更したりできます。このようなタスクには、GRUB、grubby、および Boot Loader Specification (BLS) ファイルを使用できます。

次のセクションでは、GRUB と grubby を使用してブートメニューの基本的なカスタマイズを行う方法について説明します。

8.1. GRUB 設定ファイル

BIOS ベースのマシンでは /boot/grub2/grub.cfg であり、UEFI ベースのマシンでは /boot/efi/EFI/redhat/grub.cfg であるブートローダー設定ファイルについて学びます。

GRUB スクリプトはユーザーのコンピューターを検索して、スクリプトが見つけたオペレーティングシステムに基づくブートメニューを構築します。最新のシステムブートオプションを反映させるために、カーネルが更新されるか新規カーネルが追加されると、ブートメニューは自動的に再構築されます。

GRUB は、一連のスクリプトを使用してメニューを構築します。これらは /etc/grub.d/ ディレクトリーにあります。このスクリプトは /etc/grub.d/ ディレクトリーに格納されており、以下のファイルが含まれます。

-

00_header:/etc/default/grubファイルから GRUB 設定を読み込みます。 -

01_users:user.cfgファイルから root パスワードを読み取ります。 -

10_linux: Red Hat Enterprise Linux のデフォルトのパーティションでカーネルを見つけます。 -

30_os-prober。別のパーティションで見つかったオペレーティングシステム用にエントリーを構築します。 -

40_custom: 追加のメニューエントリー作成に使用可能なテンプレートです。

GRUB はスクリプトを /etc/grub.d/ ディレクトリーからアルファベット順に読み取るため、スクリプトの名前を変更して、特定のメニューエントリーの起動順序を変更できます。

8.2. 起動可能なカーネルのリストを非表示にする

システムの起動時に GRUB が起動可能なカーネルのリストを表示しないようにすることができます。

手順

/etc/default/grubファイルでGRUB_TIMEOUT_STYLEオプションを次のように設定します。GRUB_TIMEOUT_STYLE=hidden

変更を有効にするために

grub.cfgファイルを再ビルドします。BIOS ベースのマシンで、次のように入力します。

# grub2-mkconfig -o /boot/grub2/grub.cfgUEFI ベースのマシンでは、次のように入力します。

# grub2-mkconfig -o /boot/efi/EFI/redhat/grub.cfg

- 起動時に Esc キーを押すと、起動可能なカーネルのリストが表示されます。

/etc/default/grub ファイルで GRUB_TIMEOUT を 0 に設定して、起動可能なカーネルのリストを非表示にしないでください。このように設定すると、システムが常にデフォルトのメニューエントリーで直ちに起動し、デフォルトのカーネルが起動に失敗した場合に、以前のカーネルを起動することができなくなります。

8.3. GRUB 設定ファイルを使用してデフォルトのブートエントリーを変更する

デフォルトのカーネルパッケージタイプを指定して、デフォルトのブートエントリーを変更できます。

手順

grub2-set-defaultコマンドにインデックスを渡して、デフォルトでロードするオペレーティングシステムまたはカーネルを指定します。以下に例を示します。# grubby --set-default-index=1 The default is /boot/loader/entries/d5151aa93c444ac89e78347a1504d6c6-4.18.0-348.el8.x86_64.conf with index 1 and kernel /boot/vmlinuz-4.18.0-348.el8.x86_64GRUB は、

/boot/grub2/grubenvのsaved_entryディレクティブのキーとして数値を使用して、オペレーティングシステムがロードされるデフォルトの順序を変更することをサポートしています。注記インデックスカウントはゼロから始まります。したがって、前の例では、GRUB は 2 番目のエントリーをロードします。次にインストールされたカーネルで、インデックス値は上書きされます。

注記grubbyを使用して、カーネルのインデックスを見つけることもできます。詳細は、カーネルの GRUB メニューエントリーの表示 を参照してください。オプション: システムが常に特定のメニューエントリーを使用するように強制します。

利用可能なメニューエントリーを一覧表示します。

# grubby --info=ALL/etc/default/grubファイルのGRUB_DEFAULTディレクティブのキーとして、メニューエントリー名またはリスト内のメニューエントリーの位置番号を使用します。以下に例を示します。GRUB_DEFAULT=example-gnu-linux

変更を有効にするために

grub.cfgファイルを再ビルドします。BIOS ベースのマシンで、次のように入力します。

# grub2-mkconfig -o /boot/grub2/grub.cfgUEFI ベースのマシンでは、次のように入力します。

# grub2-mkconfig -o /boot/efi/EFI/redhat/grub.cfg

第9章 GRUB の再インストール

GRUB ブートローダーを再インストールすると、通常は GRUB の誤ったインストール、ファイルの欠落、またはシステムの破損によって発生する特定の問題を修正できます。不足しているファイルを復元し、ブート情報を更新することで、これらの問題を解決できます。

GRUB を再インストールする理由:

- GRUB ブートローダーパッケージをアップグレードします。

- 別のドライブにブート情報を追加する。

- インストール済みのオペレーティングシステムを制御するために、ユーザーが GRUB 2 ブートローダーを必要としている。ただし、一部のオペレーティングシステムには独自のブートローダーがインストールされており、GRUB を再インストールすると、目的のオペレーティングシステムに制御が戻ります。

GRUB は、ファイルが破損していない場合にのみファイルを復元します。

9.1. BIOS ベースマシンへの GRUB の再インストール

BIOS ベースのシステムに GRUB ブートローダーを再インストールできます。GRUB パッケージを更新した後は、必ず GRUB を再インストールしてください。

これにより、既存の GRUB が上書きされ、新しい GRUB がインストールされます。インストール中にシステムでデータの破損やブートクラッシュが発生しないことを確認します。

手順

GRUB がインストールされているデバイスに GRUB を再インストールします。たとえば、

sdaがデバイスの場合は、以下のようになります。# grub2-install /dev/sdaシステムを再起動して、変更を有効にします。

# reboot

関連情報

-

grub-install(1)man ページ

9.2. UEFI ベースマシンへの GRUB の再インストール

UEFI ベースのシステムに GRUB ブートローダーを再インストールできます。

インストール中にシステムでデータの破損やブートクラッシュが発生しないことを確認します。

手順

grub2-efiおよびshimブートローダーファイルを再インストールします。# yum reinstall grub2-efi shimシステムを再起動して、変更を有効にします。

# reboot

9.3. IBM Power マシンに GRUB を再インストールする

IBM Power システムの Power PC Reference Platform (PReP) ブートパーティションに GRUB ブートローダーを再インストールできます。GRUB パッケージを更新した後は、必ず GRUB を再インストールしてください。

これにより、既存の GRUB が上書きされ、新しい GRUB がインストールされます。インストール中にシステムでデータの破損やブートクラッシュが発生しないことを確認します。

手順

GRUB を保存するディスクパーティションを特定します。

# bootlist -m normal -o sda1

ディスクパーティションに GRUB を再インストールします。

# grub2-install partitionパーティションを、前の手順で見つけた GRUB パーティション(/dev/sda1など) に置き換えます。システムを再起動して、変更を有効にします。

# reboot

関連情報

-

grub-install(1)man ページ

9.4. GRUB のリセット

GRUB をリセットすると、すべての GRUB 設定ファイルとシステム設定が完全に削除され、ブートローダーが再インストールされます。すべての構成設定をデフォルト値にリセットして、破損したファイルや不適切な設定によって引き起こされた障害を修正できます。

次の手順では、ユーザーが行ったすべてのカスタマイズを削除します。

手順

設定ファイルを削除します。

# rm /etc/grub.d/* # rm /etc/sysconfig/grub

パッケージを再インストールします。

BIOS ベースのマシンで、次のように入力します。

# yum reinstall grub2-toolsUEFI ベースのマシンでは、次のように入力します。

# yum reinstall grub2-efi shim grub2-tools

変更を有効にするために

grub.cfgファイルを再ビルドします。BIOS ベースのマシンで、次のように入力します。

# grub2-mkconfig -o /boot/grub2/grub.cfgUEFI ベースのマシンでは、次のように入力します。

# grub2-mkconfig -o /boot/efi/EFI/redhat/grub.cfg

-

GRUB の再インストール 手順に従って、

/boot/パーティションに GRUB を復元します。

第10章 GRUB をパスワードで保護する

GRUB をパスワードで保護するには、次の 2 つの方法があります。

- メニューエントリーの修正にはパスワードが必要ですが、既存のメニューエントリーの起動には必要ありません。

- メニューエントリーを変更したり、既存のメニューエントリーを起動するには、パスワードが必要です。

10.1. メニューエントリーを変更するためだけにパスワード保護を設定する

GRUB メニューエントリーを変更するためのパスワード認証をサポートするように GRUB を設定できます。この手順では、ハッシュ形式のパスワードを含む /boot/grub2/user.cfg ファイルを作成します。

grub2-setpassword コマンドを使用してパスワードを設定すると、権限のない修正からメニューエントリーは保護されますが、権限のない起動からは保護されません。

手順

root で

grub2-setpasswordコマンドを実行します。# grub2-setpasswordユーザーのパスワードを入力し、Enter キーを押してパスワードを確認します。

Enter password: Confirm the password:

root ユーザーは、/boot/grub2/grub.cfg ファイルで定義され、パスワードが変更されます。したがって、ブート中にブートエントリーを変更するには、root ユーザー名とパスワードが必要です。

10.2. メニューエントリーの変更および起動のためのパスワード保護の設定

GRUB を設定して、メニューエントリーが不正に変更されたり、不正に起動されたりするのを防ぐことができます。

GRUB パスワードを忘れると、再設定したエントリーを起動できなくなります。

手順

-

/boot/loader/entries/ディレクトリーから、変更するブートエントリーのブートローダー仕様 (BLS) ファイルを開きます。 -

grub_usersで始まる行を見つけます。このパラメーターは追加の引数をmenuentryに渡します。 grub_users属性を、スーパーユーザー以外にエントリーを起動できるユーザー名に設定します。デフォルトでは、このユーザーはrootです。サンプル設定ファイルは次のとおりです。title Red Hat Enterprise Linux (4.18.0-221.el8.x86_64) 8.3 (Ootpa) version 4.18.0-221.el8.x86_64 linux /vmlinuz-4.18.0-221.el8.x86_64 initrd /initramfs-4.18.0-221.el8.x86_64.img $tuned_initrd options $kernelopts $tuned_params id rhel-20200625210904-4.18.0-221.el8.x86_64 grub_users root grub_arg --unrestricted grub_class kernel-

BLSファイルを保存して閉じます。

すべてのメニューエントリーを起動から保護したい場合は、grub_users 属性を直接設定できます。たとえば、root がユーザーの場合は、以下を行います。

# grub2-editenv - set grub_users="root"第11章 仮想化環境でカーネルパニックのパラメーターを無効のままにする

RHEL 8 に仮想マシンを設定する場合は、仮想マシンで偽ソフトロックアップが発生する可能性があるため、カーネルパラメーター softlockup_panic および nmi_watchdog を有効にしないでください。また、カーネルパニックは必要ありません。

以下のセクションで、このアドバイスの背後にある理由を見つけてください。

11.1. ソフトロックアップとは

ソフトロックアップは、通常、タスクが再スケジュールされずに CPU のカーネル領域で実行しているときにバグによって生じる状況です。また、このタスクは、その他のタスクがその特定の CPU で実行することを許可しません。これにより、警告が、システムコンソールを介してユーザーに表示されます。この問題は、ソフトロックアップの発生 (fire) とも呼ばれます。

関連情報

11.2. カーネルパニックを制御するパラメーター

ソフトロックの検出時にシステムの動作を制御する、以下のカーネルパラメーターを設定できます。

- softlockup_panic

ソフトロックアップが検出されたときにカーネルでパニックを発生させるどうかを制御します。

タイプ 値 Effect 整数

0

カーネルが、ソフトロックアップでパニックにならない

整数

1

カーネルが、ソフトロックアップでパニックになる

RHEL 8 では、この値のデフォルトは 0 です。

システムでパニックを発生させるには、その前にハードロックアップを検出する必要があります。検出は、

nmi_watchdogパラメーターで制御されます。- nmi_watchdog

ロックアップ検出メカニズム (

watchdogs) がアクティブかどうかを制御します。このパラメーターは整数型です。値 Effect 0

ロックアップ検出を無効にする

1

ロックアップ検出を有効にする

ハードロックアップ検出は、各 CPU で割り込みに応答する機能を監視します。

- watchdog_thresh

ウォッチドッグの

hrtimer、NMI イベント、およびソフトロックアップまたはハードロックアップのしきい値を制御します。デフォルトのしきい値 ソフトロックアップのしきい値 10 秒

2 *

watchdog_threshこのパラメーターをゼロに設定すると、ロックアップ検出を無効にします。

11.3. 仮想化環境で誤ったソフトロックアップ

ソフトロックアップとは で説明されている物理ホストでのソフトロックアップの発生は、通常、カーネルまたはハードウェアのバグを示しています。仮想化環境のゲストオペレーティングシステムで同じ現象が発生すると、誤った警告が表示される場合があります。

ホストの負荷が重い場合や、メモリーなどの特定リソースに対する競合が多い場合は、通常、ソフトロックアップが誤って発生します。これは、ホストが 20 秒よりも長い期間、ゲストの CPU をスケジュールすることが原因となる場合があります。その後、再度、ホストで実行するようにゲスト CPU がスケジュールされると、タイマーにより発生する 時間ジャンプ が発生します。タイマーには、ウォッチドッグの hrtimer も含まれます。これにより、ゲスト CPU のソフトロックアップを報告できます。

仮想化環境でのソフトロックアップは誤りである可能性があるため、ゲスト CPU でソフトロックアップが報告されたときにシステムパニックを発生させるカーネルパラメーターは有効にしないでください。

ゲストのソフトロックアップについて理解するには、ホストがゲストをタスクとしてスケジュールしてから、ゲストが独自のタスクをスケジュールしていることを理解することが重要になります。

第12章 データベースサーバーのカーネルパラメーターの調整

特定のデータベースアプリケーションのパフォーマンスに影響を与える可能性のあるカーネルパラメーターのセットには、様々なものがあります。データベースサーバーとデータベースの効率的な運用を確保するには、それぞれのカーネルパラメーターを適切に設定します。

12.1. データベースサーバーの概要

データベースサーバーは、データベース管理システム (DBMS) の機能を提供するサービスです。DBMS は、データベース管理のためのユーティリティーを提供し、エンドユーザー、アプリケーション、およびデータベースと対話します。

Red Hat Enterprise Linux 8 は、以下のデータベース管理システムを提供します。

- MariaDB 10.3

- MariaDB 10.5 - RHEL 8.4 以降で利用できます。

- MySQL 8.0

- PostgreSQL 10

- PostgreSQL 9.6

- PostgreSQL 12 - RHEL 8.1.1 以降で利用できます。

- PostgreSQL 13 - RHEL 8.4 以降で利用できます。

- PostgreSQL 15 - RHEL 8.8 以降で利用できます。

12.2. データベースアプリケーションのパフォーマンスに影響するパラメーター

次のカーネルパラメーターは、データベースアプリケーションのパフォーマンスに影響します。

- fs.aio-max-nr

サーバー上でシステムが処理できる非同期 I/O 操作の最大数を定義します。

注記fs.aio-max-nrパラメーターを増やしても、aio の制限以上を追加することはありません。- fs.file-max

システムがインスタンスで対応するファイルハンドル (一時ファイル名または開いているファイルに割り当てられた ID) の最大数を定義します。

カーネルは、アプリケーションからファイルハンドルが要求されるたびに、ファイルハンドルを動的に割り当てます。ただし、カーネルは、そのファイルハンドルがアプリケーションによって解放されたときに解放しません。代わりに、カーネルはこれらのファイルハンドルをリサイクルします。これは、現在使用しているファイルハンドルの数が少なくても、時間の経過とともに割り当てられたファイルハンドルの合計が増加することを意味します。

- kernel.shmall

-

システム全体で使用できる共有メモリーページの合計を定義します。メインメモリー全体を使用するには、

kernel.shmallパラメーターの値が、メインメモリーの合計サイズ以下である必要があります。 - kernel.shmmax

- Linux プロセスが仮想アドレス空間に割り当てることができる 1 つの共有メモリーセグメントの最大サイズをバイト単位で定義します。

- kernel.shmmni

- データベースサーバーが処理できる共有メモリーセグメントの最大数を定義します。

- net.ipv4.ip_local_port_range

- 特定のポート番号なしでデータベースサーバーに接続するプログラムにシステムが使用できるポート範囲を定義します。

- net.core.rmem_default

- TCP (Transmission Control Protocol) を介してデフォルトの受信ソケットメモリーを定義します。

- net.core.rmem_max

- TCP (Transmission Control Protocol) による最大受信ソケットメモリーを定義します。

- net.core.wmem_default

- TCP (Transmission Control Protocol) によるデフォルトの送信ソケットメモリーを定義します。

- net.core.wmem_max

- TCP (Transmission Control Protocol) による最大送信ソケットメモリーを定義します。

- vm.dirty_bytes / vm.dirty_ratio

-

ダーティーデータを生成するプロセスが

write()関数で開始するダーティー可能メモリーの割合 (バイト単位) でしきい値を定義します。

一度に指定できるのは、vm.dirty_bytes または vm.dirty_ratio の いずれか です。

- vm.dirty_background_bytes / vm.dirty_background_ratio

- カーネルがダーティーデータをハードディスクにアクティブに書き込もうとする、ダーティー可能なメモリーの割合 (バイト単位) でしきい値を定義します。

一度に指定できるのは、vm.dirty_background_bytes または vm.dirty_background_ratio の いずれか です。

- vm.dirty_writeback_centisecs

ハードディスクへのダーティーデータの書き込みを行うカーネルスレッドの起動を定期的に行う間隔を定義します。

このカーネルパラメーターは、100 分の 1 秒単位で測定されます。

- vm.dirty_expire_centisecs

ダーティーデータがハードディスクに書き込まれるまでの時間を定義します。

このカーネルパラメーターは、100 分の 1 秒単位で測定されます。

第13章 カーネルロギングの使用

ログファイルは、システム (カーネル、サービス、および実行中のアプリケーションなど) に関するメッセージが含まれるファイルです。Red Hat Enterprise Linux におけるロギングシステムは、組み込みの syslog プロトコルに基づいています。さまざまなユーティリティーがこのシステムを使用してイベントを記録し、ログファイルにまとめます。このファイルは、オペレーティングシステムの監査や問題のトラブルシューティングに役に立ちます。

13.1. カーネルリングバッファーとは

コンソールは、システムの起動プロセス時に、システム起動の初期段階に関する重要な情報を多数提供します。先に出力されたメッセージが失われないように、カーネルではリングバッファーと呼ばれるものが使用されています。このバッファーは、カーネルコード内の printk() 関数により生成されるブートメッセージなど、すべてのメッセージを格納します。次に、カーネルリングバッファーからのメッセージは、syslog サービスなどの永続ストレージのログファイルに読み込まれ、保存されます。

上記のバッファーは、固定サイズの循環データ構造であり、カーネルにハードコーディングされています。ユーザーは、dmesg コマンドまたは /var/log/boot.log ファイル介して、カーネルリングバッファーに保存されているデータを表示できます。リングバッファーが満杯になると、新しいデータにより古いデータが上書きされます。

関連情報

-

syslog(2)およびdmesg(1)の man ページ

13.2. ログレベルおよびカーネルロギングにおける printk のロール

カーネルが報告する各メッセージには、メッセージの重要性を定義するログレベルが関連付けられています。カーネルリングバッファーは、カーネルリングバッファーとは で説明されているように、すべてのログレベルのカーネルメッセージを収集します。バッファーからコンソールに出力されるメッセージを定義するのは kernel.printk パラメーターです。

ログレベルの値は、以下の順序で分類されます。

- 0

- カーネルの緊急事態。システムが利用できません。

- 1

- カーネルアラート。すぐに対処する必要があります。

- 2

- 重大な問題があると見なされるカーネルの状態。

- 3

- 一般的なカーネルのエラー状態。

- 4

- 一般的なカーネルの警告状態。

- 5

- 正常だが重要な状態に関するカーネル通知。

- 6

- カーネル情報メッセージ。

- 7

- カーネルのデバッグレベルのメッセージ。

RHEL 8 の kernel.printk には、デフォルトで以下の 4 つの値が含まれます。

# sysctl kernel.printk

kernel.printk = 7 4 1 7この 4 つの値は、順に以下を定義します。

- コンソールログレベル。コンソールに出力されるメッセージの最低優先度を定義します。

- 明示的なログレベルが付いていないメッセージのデフォルトのログレベル。

- コンソールのログレベルに、可能な限り低いログレベル設定を設定します。

起動時のコンソールのログレベルのデフォルト値を設定します。

上記の各値は、エラーメッセージを処理するさまざまなルールを定義します。

デフォルトの 7 4 1 7 printk 値を使用することで、カーネルアクティビティーのデバッグを改善できます。ただし、シリアルコンソールと組み合わせると、この printk 設定により激しい I/O バーストが発生し、RHEL システムが一時的に応答しなくなる可能性があります。通常 4 4 1 7 に printk 値を設定するとこのような状況を回避できますが、代わりに追加のデバッグ情報が失われてしまいます。

また、quiet、debug などの特定のカーネルコマンドラインパラメーターにより、デフォルトの kernel.printk 値が変更される点に注意してください。

関連情報

-

syslog(2)の man ページ

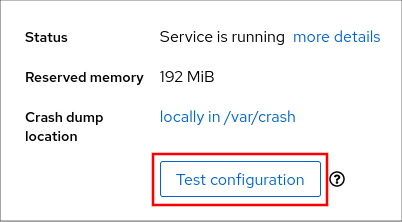

第14章 kdump のインストール

RHEL 8 の新しいインストールでは、デフォルトで kdump サービスがインストールされアクティベートされます。kdump の概要、および kdump がデフォルトで有効になっていない場合のインストール方法について、情報を提供して手順を説明します。

14.1. kdump とは

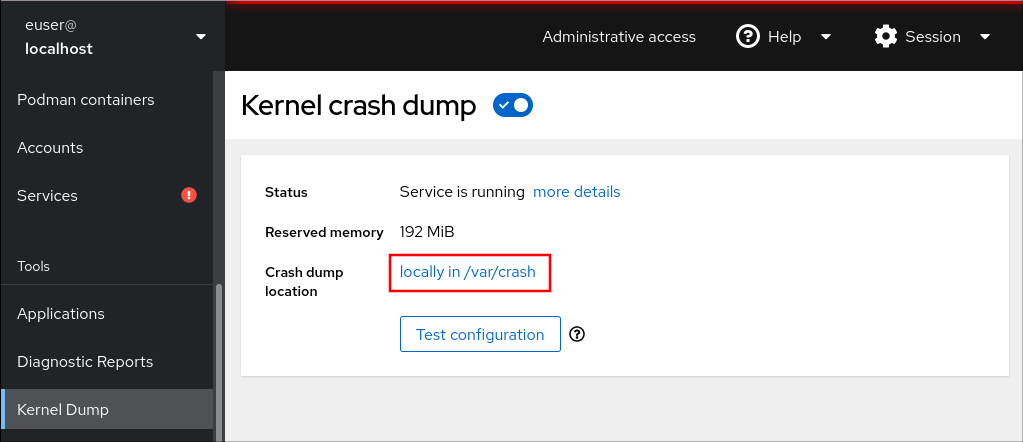

kdump は、クラッシュダンプメカニズムを提供し、クラッシュダンプまたは vmcore ファイルとして知られるダンプファイルを生成するサービスです。vmcore ファイルには、分析とトラブルシューティングに役立つシステムメモリーのコンテンツが含まれています。kdump は kexec システムコールを使用して、再起動せずに キャプチャーカーネル である 2 番目のカーネルで起動し、クラッシュしたカーネルメモリーの内容をキャプチャしてファイルに保存します。この別のカーネルは、システムメモリーの予約部分で使用できます。

カーネルクラッシュダンプは、システム障害時に利用できる唯一の情報になります。したがって、ミッションクリティカルな環境では、kdump を稼働させることが重要です。Red Hat は、通常のカーネル更新サイクルで kexec-tools を定期的に更新してテストすることを推奨します。これは、新しいカーネル機能をインストールする場合に特に重要です。

kdump は、マシンにインストールされているすべてのカーネルに対して、または指定したカーネルに対してのみ有効にできます。これは、マシンで複数のカーネルが使用されており、その一部が安定しており、クラッシュの心配がない場合に役立ちます。kdump をインストールすると、デフォルトの /etc/kdump.conf ファイルが作成されます。/etc/kdump.conf ファイルにはデフォルトの最小 kdump 設定が含まれており、これを編集して kdump 設定をカスタマイズできます。

14.2. Anaconda を使用した kdump のインストール

Anaconda インストーラーでは、対話式インストール時に kdump 設定用のグラフィカルインターフェイス画面が表示されます。インストーラー画面のタイトルは KDUMP で、メインの インストールの概要 画面から利用できます。kdump を有効にして、必要な量のメモリーを予約できます。

手順

KDUMP フィールドで、

kdumpがまだ有効になっていない場合は有効にします。

- メモリー予約をカスタマイズする必要がある場合は、Kdump Memory Reservation で Manual を選択します。

KDUMP フィールドの Memory To Be Reserved (MB) で、

kdumpに必要なメモリー予約を設定します。

14.3. コマンドラインで kdump のインストール

カスタムの Kickstart インストールなどの一部のインストールオプションでは、デフォルトで kdump がインストールまたは有効化されない場合があります。この場合は、以下の手順を行ってください。

前提条件

- アクティブな RHEL サブスクリプションがある。

-

システムの CPU アーキテクチャー用の

kexec-toolsパッケージを含むリポジトリーがある。 -

kdump設定とターゲットの要件をすべて満たしている。詳細は 対応している kdump 設定とターゲット を参照してください。

手順

kdumpがシステムにインストールされているかどうかを確認します。# rpm -q kexec-tools

このパッケージがインストールされている場合は以下を出力します。

kexec-tools-2.0.17-11.el8.x86_64

このパッケージがインストールされていない場合は以下を出力します

package kexec-tools is not installed

kdumpおよび必要なパッケージをインストールします。# dnf install kexec-tools

kernel-3.10.0-693.el7 以降では、kdump で Intel IOMMU ドライバーがサポートされます。kernel-3.10.0-514[.XYZ].el7 および初期バージョンの場合は、応答しないキャプチャーカーネルを回避するために Intel IOMMU が無効になっていることを確認する必要があります。

第15章 コマンドラインで kdump の設定

kdump 用メモリーは、システムの起動時に予約されます。メモリーサイズは、システムの GRUB (Grand Unified Bootloader) 設定ファイルで設定されています。メモリーサイズは、設定ファイルで指定された crashkernel= 値と、システムの物理メモリーのサイズにより異なります。

15.1. kdump サイズの見積もり

kdump 環境の計画および構築を行う際に、クラッシュダンプファイルに必要な領域を把握しておくことが重要です。

makedumpfile --mem-usage コマンドは、クラッシュダンプファイルに必要な領域を推定し、メモリー使用量に関するレポートを生成します。このレポートは、ダンプレベルと、除外して問題ないページを判断するのに役立ちます。

手順

次のコマンドを実行して、メモリー使用量に関するレポートを生成します。

# makedumpfile --mem-usage /proc/kcore TYPE PAGES EXCLUDABLE DESCRIPTION ------------------------------------------------------------- ZERO 501635 yes Pages filled with zero CACHE 51657 yes Cache pages CACHE_PRIVATE 5442 yes Cache pages + private USER 16301 yes User process pages FREE 77738211 yes Free pages KERN_DATA 1333192 no Dumpable kernel data

makedumpfile --mem-usage は、必要なメモリーをページ単位で報告します。つまり、カーネルページサイズを元に、使用するメモリーのサイズを計算する必要があります。

デフォルトでは、RHEL カーネルは、AMD64 および Intel 64 の CPU アーキテクチャーで 4KB のサイズのページを使用し、IBM POWER アーキテクチャーで 64KB のサイズのページを使用します。

15.2. メモリー使用量の設定

kdump のメモリー予約は、システムの起動中に行われます。メモリーサイズは、システムの GRUB (Grand Unified Bootloader) 設定で設定されます。メモリーサイズは、設定ファイルで指定された crashkernel= オプションの値と、システムの物理メモリーのサイズにより異なります。

crashkernel= オプションはさまざまな方法で定義できます。crashkernel= 値を指定するか、auto オプションを設定できます。crashkernel=auto パラメーターは、システムの物理メモリーの合計量に基づいて、メモリーを自動的に予約します。これを設定すると、カーネルは、キャプチャーカーネルに必要な適切な量のメモリーを自動的に予約します。これにより、OOM (Out-of-Memory) エラーの回避に役立ちます。

kdump の自動メモリー割り当ては、システムのハードウェアアーキテクチャーと利用可能なメモリーサイズによって異なります。

たとえば、AMD64 および Intel 64 の場合には、crashkernel=auto パラメーターは、利用可能なメモリーが 1GB を超える場合にのみ機能します。64 ビット ARM アーキテクチャーと IBM Power Systems には、2 GB 以上の使用可能なメモリーが必要です。

システムに、自動割り当ての最小メモリーしきい値より少ないメモリーしかない場合は、手動で予約メモリーの量を設定できます。

前提条件

- システムの root 権限がある。

-

kdump設定とターゲットの要件をすべて満たしている。詳細は 対応している kdump 設定とターゲット を参照してください。

手順

crashkernel=オプションを準備してください。たとえば、128 MB のメモリーを予約するには、以下を使用します。

crashkernel=128M

または、インストールされているメモリーの合計量に応じて、予約メモリーサイズを変数に設定できます。変数へのメモリー予約の構文は

crashkernel=<range1>:<size1>,<range2>:<size2>です。以下に例を示します。crashkernel=512M-2G:64M,2G-:128M

システムメモリーの合計量が 512 MB - 2 GB の範囲にある場合、64 MB のメモリーを予約します。メモリーの合計量が 2 GB を超える場合、メモリー予約は 128 MB になります。

予約メモリーのオフセット。

一部のシステムでは、

crashkernelの予約が早い段階で行われるため、特定の固定オフセットでメモリーを予約する必要があります。また、特別な用途のために、さらに多くのメモリーの予約が必要になることもあります。オフセットを定義すると、予約メモリーはそこから開始されます。予約メモリーをオフセットするには、以下の構文を使用します。crashkernel=128M@16M

この例では、

kdumpは 16 MB (物理アドレス0x01000000) から始まる 128 MB のメモリーを予約します。offset パラメーターを 0 に設定するか、完全に省略すると、kdumpは予約メモリーを自動的にオフセットします。変数のメモリー予約を設定する場合は、この構文を使用することもできます。その場合、オフセットは常に最後に指定されます。以下に例を示します。crashkernel=512M-2G:64M,2G-:128M@16M

crashkernel=オプションをブートローダー設定に適用します。# grubby --update-kernel=ALL --args="crashkernel=<value>"<value>は、前のステップで準備したcrashkernel=オプションの値に置き換えます。

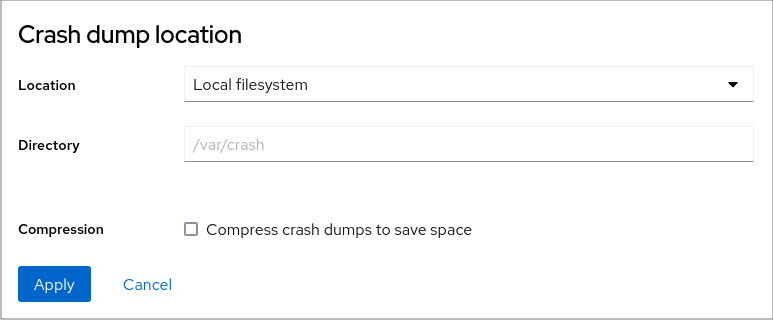

15.3. kdump ターゲットの設定

クラッシュダンプは通常、ローカルファイルシステムにファイルとして保存され、デバイスに直接書き込まれます。または、NFS プロトコルまたは SSH プロトコルを使用して、ネットワーク経由でクラッシュダンプを送信するように設定できます。クラッシュダンプファイルを保存するオプションは、一度に 1 つだけ設定できます。デフォルトの動作では、ローカルファイルシステムの /var/crash/ ディレクトリーに保存されます。

前提条件

- システムの root 権限がある。

-

kdump設定とターゲットの要件をすべて満たしている。詳細は 対応している kdump 設定とターゲット を参照してください。

手順

ローカルファイルシステムの

/var/crash/ディレクトリーにクラッシュダンプファイルを保存するには、/etc/kdump.confファイルを変更して、パスを指定します。path /var/crash

path /var/crashオプションは、kdumpがクラッシュダンプファイルを保存するファイルシステムへのパスを表します。注記-

/etc/kdump.confファイルでダンプターゲットを指定すると、path は指定されたダンプ出力先に対する相対パスになります。 -

/etc/kdump.confファイルでダンプターゲットを指定しない場合、パスはルートディレクトリーからの 絶対 パスを表します。

現在のシステムにマウントされている内容に応じて、ダンプターゲットと調整されたダンプパスが自動的に適用されます。

kdumpによって生成されるクラッシュダンプファイルと付随するファイルを保護するには、ユーザー権限や SELinux コンテキストなど、ターゲットの宛先ディレクトリーに適切な属性を設定する必要があります。さらに、次のように、kdump.confファイル内のkdump_post.shなどのスクリプトを定義できます。kdump_post <path_to_kdump_post.sh>

kdump_postディレクティブは、kdump が指定された宛先にクラッシュダンプのキャプチャーと保存を完了した 後に 実行されるシェルスクリプトまたはコマンドを指定します。このメカニズムを使用すると、kdumpの機能を拡張して、ファイル権限の調整などのアクションを実行できます。-

例15.1 kdump ターゲット設定

# grep -v ^# /etc/kdump.conf | grep -v ^$

ext4 /dev/mapper/vg00-varcrashvol

path /var/crash

core_collector makedumpfile -c --message-level 1 -d 31

ここでは、ダンプターゲットが指定されているため (ext4/dev/mapper/vg00-varcrashvol)、/var/crash にマウントされます。path オプションも /var/crash に設定されているため、kdump は vmcore ファイルを /var/crash/var/crash ディレクトリーに保存します。

クラッシュダンプを保存するローカルディレクトリーを変更するには、

rootとして/etc/kdump.conf設定ファイルを編集します。-

#path /var/crashの行頭にあるハッシュ記号 (#) を削除します。 値を対象のディレクトリーパスに置き換えます。以下に例を示します。

path /usr/local/cores

重要RHEL 8 では、

kdumpsystemdサービスの起動時に、pathディレクティブを使用してkdumpターゲットとして定義されたディレクトリーが存在し、失敗を回避する必要があります。この動作は、サービスの起動時にディレクトリーが存在しなかった場合はディレクトリーが自動的に作成されていた RHEL の以前のバージョンとは異なります。

-

ファイルを別のパーティションに書き込むには、

/etc/kdump.conf設定ファイルを編集します。必要に応じて

#ext4の行頭にあるハッシュ記号 (#) を削除します。-

デバイス名 (

#ext4 /dev/vg/lv_kdump行) -

ファイルシステムラベル (

#0ext4 LABEL=/boot行) -

UUID (

#ext4 UUID=03138356-5e61-4ab3-b58e-27507ac41937の行)

-

デバイス名 (

ファイルシステムタイプとデバイス名、ラベル、または UUID を必要な値に変更します。UUID 値を指定するための正しい構文は、

UUID="correct-uuid"とUUID=correct-uuidの両方です。以下に例を示します。ext4 UUID=03138356-5e61-4ab3-b58e-27507ac41937

重要LABEL=またはUUID=を使用してストレージデバイスを指定することが推奨されます。/dev/sda3などのディスクデバイス名は、再起動した場合に一貫性が保証されません。IBM Z ハードウェアで Direct Access Storage Device (DASD) を使用する場合は、

kdumpに進む前に、ダンプデバイスが/etc/dasd.confで正しく指定されていることを確認してください。

クラッシュダンプを直接書き込むには、

/etc/kdump.conf設定ファイルを修正します。-

#raw /dev/vg/lv_kdumpの行頭にあるハッシュ記号 (#) を削除します。 値を対象のデバイス名に置き換えます。以下に例を示します。

raw /dev/sdb1

-

NFSプロトコルを使用してクラッシュダンプをリモートマシンに保存するには、次の手順を実行します。-

#nfs my.server.com:/export/tmpの行頭にあるハッシュ記号 (#) を削除します。 値を、正しいホスト名およびディレクトリーパスに置き換えます。以下に例を示します。

nfs penguin.example.com:/export/cores

変更を有効にするには、

kdumpサービスを再起動します。sudo systemctl restart kdump.service

注記NFS ディレクティブを使用して NFS ターゲットを指定すると、

kdump.service はディスク領域をチェックするために NFS ターゲットを自動的にマウントしようとします。事前に NFS ターゲットをマウントする必要はありません。kdump.service がターゲットをマウントしないようにするには、kdump.confでdracut_args --mountディレクティブを使用します。これにより、kdump.service は--mount引数を指定してdracutユーティリティーを呼び出し、NFS ターゲットを指定します。

-

SSH プロトコルを使用してクラッシュダンプをリモートマシンに保存するには、次の手順を実行します。

-

#ssh user@my.server.comの行頭にあるハッシュ記号 (#) を削除します。 - 値を正しいユーザー名およびホスト名に置き換えます。

SSH キーを設定に含めます。

-

#sshkey /root/.ssh/kdump_id_rsaの行頭にあるハッシュ記号 ("#") を削除します。 値を、ダンプ先のサーバー上の正しいキーの場所に変更します。以下は例になります。

ssh john@penguin.example.com sshkey /root/.ssh/mykey

-

-

15.4. kdump コアコレクターの設定

kdump では、core_collector を使用してクラッシュダンプイメージをキャプチャーします。RHEL では、makedumpfile ユーティリティーがデフォルトのコアコレクターです。これは、以下に示すプロセスによりダンプファイルを縮小するのに役立ちます。

- クラッシュダンプファイルのサイズを圧縮し、さまざまなダンプレベルを使用して必要なページのみをコピーする

- 不要なクラッシュダンプページを除外する

- クラッシュダンプに含めるページタイプをフィルタリングする

構文

core_collector makedumpfile -l --message-level 1 -d 31

オプション

-

-c、-l、または-p:zlib(-cオプションの場合)、lzo(-lオプションの場合)、またはsnappy(-pオプションの場合) のいずれかを使用して、ページごとに圧縮ダンプファイルの形式を指定します。 -

-d(dump_level): ページを除外して、ダンプファイルにコピーされないようにします。 -

--message-level: メッセージタイプを指定します。このオプションでmessage_levelを指定すると、出力の表示量を制限できます。たとえば、message_levelで 7 を指定すると、一般的なメッセージとエラーメッセージを出力します。message_levelの最大値は 31 です。

前提条件

- システムの root 権限がある。

-

kdump設定とターゲットの要件をすべて満たしている。詳細は 対応している kdump 設定とターゲット を参照してください。

手順

-

rootで、/etc/kdump.conf設定ファイルを編集し、#core_collector makedumpfile -l --message-level 1 -d 31の行頭にあるハッシュ記号 ("#") を削除します。 - クラッシュダンプファイルの圧縮を有効にするには、以下のコマンドを実行します。

core_collector makedumpfile -l --message-level 1 -d 31

-l オプションにより、dump の圧縮ファイル形式を指定します。-d オプションで、ダンプレベルを 31 に指定します。--message-level オプションで、メッセージレベルを 1 に指定します。

また、-c オプションおよび -p オプションを使用した以下の例を検討してください。

-

-cを使用してクラッシュダンプファイルを圧縮するには、以下のコマンドを実行します。

core_collector makedumpfile -c -d 31 --message-level 1

-

-pを使用してクラッシュダンプファイルを圧縮するには、以下のコマンドを実行します。

core_collector makedumpfile -p -d 31 --message-level 1

関連情報

-

makedumpfile(8)の man ページ - kdump の設定ファイル

15.5. kdump のデフォルト障害応答の設定

デフォルトでは、設定したターゲットの場所で kdump がクラッシュダンプファイルの作成に失敗すると、システムが再起動し、ダンプがプロセス内で失われます。デフォルトの障害応答を変更し、コアダンプをプライマリーターゲットに保存できない場合に別の操作を実行するように kdump を設定できます。追加のアクションは次のとおりです。

dump_to_rootfs-

コアダンプを

rootファイルシステムに保存します。 reboot- システムを再起動します。コアダンプは失われます。

halt- システムを停止します。コアダンプは失われます。

poweroff- システムの電源を切ります。コアダンプは失われます。

shell-

initramfs内からシェルセッションを実行します。コアダンプを手動で記録できます。 final_action-