Red Hat Training

A Red Hat training course is available for RHEL 8

セキュリティーの強化

Red Hat Enterprise Linux 8 システムのセキュリティーの強化

概要

多様性を受け入れるオープンソースの強化

Red Hat では、コード、ドキュメント、Web プロパティーにおける配慮に欠ける用語の置き換えに取り組んでいます。まずは、マスター (master)、スレーブ (slave)、ブラックリスト (blacklist)、ホワイトリスト (whitelist) の 4 つの用語の置き換えから始めます。この取り組みは膨大な作業を要するため、今後の複数のリリースで段階的に用語の置き換えを実施して参ります。詳細は、Red Hat CTO である Chris Wright のメッセージ をご覧ください。

Red Hat ドキュメントへのフィードバック (英語のみ)

Red Hat ドキュメントに関するご意見やご感想をお寄せください。また、改善点があればお知らせください。

Jira からのフィードバック送信 (アカウントが必要)

- Jira の Web サイトにログインします。

- 上部のナビゲーションバーで Create をクリックします。

- Summary フィールドにわかりやすいタイトルを入力します。

- Description フィールドに、ドキュメントの改善に関するご意見を記入してください。ドキュメントの該当部分へのリンクも追加してください。

- ダイアログの下部にある Create をクリックします。

第1章 インストール時の RHEL の保護

セキュリティーへの対応は、Red Hat Enterprise Linux をインストールする前にすでに始まっています。最初からシステムのセキュリティーを設定することで、追加のセキュリティー設定を実装することがより簡単になります。

1.1. BIOS および UEFI のセキュリティー

BIOS (もしくは BIOS に相当するもの) およびブートローダーをパスワードで保護することで、システムに物理的にアクセス可能な未承認ユーザーがリムーバブルメディアを使用して起動したり、シングルユーザーモードで root 権限を取得することを防ぐことができます。このような攻撃から保護するためのセキュリティー対策は、ワークステーションに関する情報の機密性とマシンの場所の両方によって異なります。

たとえば、見本市で使用されていて機密情報を含んでいないマシンでは、このような攻撃を防ぐことが重要ではないかもしれません。しかし、同じ見本市で、企業ネットワークに対して暗号化されていない SSH 秘密鍵のある従業員のノートパソコンが、誰の監視下にもなく置かれていた場合は、重大なセキュリティー侵害につながり、その影響は企業全体に及ぶ可能性があります。

一方で、ワークステーションが権限のあるユーザーもしくは信頼できるユーザーのみがアクセスできる場所に置かれてるのであれば、BIOS もしくはブートローダーの安全確保は必要ない可能性もあります。

1.1.1. BIOS パスワード

コンピューターの BIOS をパスワードで保護する主な 2 つの理由を以下に示します。[1]:

- BIOS 設定の変更の防止

- 侵入者が BIOS にアクセスできる場合、CD-ROM またはフラッシュドライブから起動するように BIOS を設定できます。このようにすると、侵入者がレスキューモードやシングルユーザーモードに入ることが可能になり、システムで任意のプロセスを開始したり、機密性の高いデータをコピーできるようになってしまいます。

- システムの起動の防止

- 一部の BIOS では、ブートプロセスをパスワードで保護できます。これを有効にすると、攻撃者は BIOS がブートローダーを開始する前にパスワード入力を求められます。

BIOS パスワードの設定方法はコンピューターメーカーで異なるため、具体的な方法はコンピューターのマニュアルを参照してください。

BIOS パスワードを忘れた場合は、マザーボードのジャンパーでリセットするか、CMOS バッテリーを外します。このため、可能な場合はコンピューターのケースをロックすることが推奨されます。ただし、CMOS バッテリーを外す前にコンピューターもしくはマザーボードのマニュアルを参照してください。

1.1.2. 非 BIOS ベースシステムのセキュリティー

その他のシステムやアーキテクチャーでは、異なるプログラムを使用して x86 システムの BIOS とほぼ同等の低レベルのタスクを実行します。UEFI (Unified Extensible Firmware Interface) シェルなどがこの例になります。

BIOS のようなプログラムをパスワード保護する方法は、メーカーにお問い合わせください。

1.2. ディスクのパーティション設定

Red Hat は、/boot、/、/home、/tmp、および /var/tmp/ の各ディレクトリーに別々のパーティションを作成することを推奨します。

/boot-

このパーティションは、システムの起動時にシステムが最初に読み込むパーティションです。Red Hat Enterprise Linux 8 でシステムを起動するのに使用するブートローダーとカーネルイメージはこのパーティションに保存されます。このパーティションは暗号化しないでください。このパーティションが

/`に含まれており、そのパーティションが暗号化されているなどの理由で利用できなくなると、システムを起動できなくなります。 /home-

ユーザーデータ (

/home) が別のパーティションではなく/に保存されていると、このパーティションが満杯になり、オペレーティングシステムが不安定になる可能性があります。また、システムを、Red Hat Enterprise Linux 8 の次のバージョンにアップグレードする際に、/homeパーティションにデータを保存できると、このデータはインストール時に上書きされないため、アップグレードが非常に簡単になります。root パーティション (/) が破損すると、データが完全に失われます。したがって、パーティションを分けることが、データ損失に対する保護につながります。また、このパーティションを、頻繁にバックアップを作成する対象にすることも可能です。 /tmpおよび/var/tmp/-

/tmpディレクトリーおよび/var/tmp/ディレクトリーは、どちらも長期保存の必要がないデータを保存するために使用されます。しかし、このいずれかのディレクトリーでデータがあふれると、ストレージ領域がすべて使用されてしまう可能性があります。このディレクトリーは/に置かれているため、こうした状態が発生すると、システムが不安定になり、クラッシュする可能性があります。そのため、このディレクトリーは個別のパーティションに移動することが推奨されます。

インストールプロセス時に、パーティションを暗号化するオプションがあります。パスフレーズを入力する必要があります。これは、パーティションのデータを保護するのに使用されるバルク暗号鍵を解除する鍵として使用されます。

1.3. インストールプロセス時のネットワーク接続の制限

Red Hat Enterprise Linux 8 をインストールする際に使用するインストールメディアは、特定のタイミングで作成されたスナップショットです。そのため、セキュリティー修正が最新のものではなく、このインストールメディアで設定するシステムが公開されてから修正された特定の問題に対して安全性に欠ける場合があります。

脆弱性が含まれる可能性のあるオペレーティングシステムをインストールする場合には、必ず、公開レベルを、必要最小限のネットワークゾーンに限定してください。最も安全な選択肢は、インストールプロセス時にマシンをネットワークから切断した状態にするネットワークなしのゾーンです。インターネット接続からのリスクが最も高く、一方で LAN またはイントラネット接続で十分な場合もあります。セキュリティーのベストプラクティスに従い、ネットワークから Red Hat Enterprise Linux 8 をインストールする場合は、お使いのリポジトリーに最も近いゾーンを選択するようにしてください。

1.4. 必要なパッケージの最小限のインストール

コンピューターの各ソフトウェアには脆弱性が潜んでいる可能性があるため、実際に使用するパッケージのみをインストールすることがベストプラクティスになります。インストールを DVD から行う場合は、インストールしたいパッケージのみを選択するようにします。その他のパッケージが必要になる場合は、後でいつでもシステムに追加できます。

1.5. インストール後の手順

以下は、Red Hat Enterprise Linux 8 のインストール直後に実行する必要があるセキュリティー関連の手順です。

システムを更新します。root で以下のコマンドを実行します。

# yum updateファイアウォールサービスの

firewalldは、Red Hat Enterprise Linux のインストールによって自動的に有効になりますが、キックスタート設定などで明示的に無効になっている場合があります。このような場合は、ファイアウォールを再度有効にしてください。firewalldを開始するには、root で次のコマンドを実行します。# systemctl start firewalld # systemctl enable firewalld

セキュリティーを強化するために、不要なサービスは無効にしてください。たとえば、コンピューターにプリンターがインストールされていない場合は、次のコマンドを使用して、

cupsサービスを無効にします。# systemctl disable cupsアクティブなサービスを確認するには、次のコマンドを実行します。

$ systemctl list-units | grep service

第2章 FIPS モードでのシステムのインストール

連邦情報処理標準 (FIPS) 140-3 で義務付けられている暗号化モジュールの自己チェックを有効にするには、FIPS モードで RHEL 8 を操作する必要があります。FIPS 準拠を目指す場合は、FIPS モードでインストールを開始することを推奨します。

2.1. 連邦情報処理標準 140 および FIPS モード

連邦情報処理標準 (FIPS) Publication 140 は、暗号モジュールの品質を確保するために米国立標準技術研究所 (NIST) によって開発された一連のコンピューターセキュリティー標準です。FIPS 140 標準は、暗号化ツールがアルゴリズムを正しく実装できるようにします。ランタイム暗号アルゴリズムと整合性セルフテストは、システムが標準の要件を満たす暗号を使用していることを確認するためのメカニズムの一部です。

RHEL システムが FIPS 承認アルゴリズムのみを使用してすべての暗号キーを生成および使用するようにするには、RHEL を FIPS モードに切り替える必要があります。

次のいずれかの方法を使用して、FIPS モードを有効にできます。

- FIPS モードでのインストールの開始

- インストール後に FIPS モードにシステムを切り替えます。

FIPS 準拠を目指す場合は、FIPS モードでインストールを開始してください。これにより、暗号鍵マテリアルの再生成と、すでにデプロイメントされているシステムの変換に関連する、結果として得られるシステムのコンプライアンスの再評価が回避されます。

FIPS 準拠のシステムを運用するには、すべての暗号化キーマテリアルを FIPS モードで作成します。さらに、暗号鍵マテリアルは、安全にラップされ、非 FIPS 環境でラップ解除されない限り、FIPS 環境から決して出てはなりません。

fips-mode-setup ツールを使用してシステムを FIPS モードに切り替えても、FIPS 140 標準への準拠は保証されません。システムを FIPS モードに設定した後にすべての暗号キーを再生成することは、可能でない場合があります。たとえば、ユーザーの暗号キーを含む既存の IdM レルムの場合、すべてのキーを再生成することはできません。FIPS モードでインストールを開始できない場合は、インストール後の設定手順を実行したり、ワークロードをインストールしたりする前に、インストール後の最初の手順として常に FIPS モードを有効にしてください。

fips-mode-setup ツールも内部的に FIPS システム全体の暗号化ポリシーを使用します。ただし、update-crypto-policies --set FIPS コマンドが実行する内容に加え、fips-mode-setup は、fips-finish-install ツールを使用して FIPS dracut モジュールを確実にインストールします。また、fips=1 ブートオプションをカーネルコマンドラインに追加し、初期 RAM ディスクを再生成します。

さらに、FIPS モードで必要な制限の適用は /proc/sys/crypto/fips_enabled ファイルの内容によって異なります。ファイルに 1 が含まれている場合、RHEL コア暗号化コンポーネントは、FIPS 承認の暗号化アルゴリズムの実装のみを使用するモードに切り替わります。/proc/sys/crypto/fips_enabled に 0 が含まれている場合、暗号化コンポーネントは FIPS モードを有効にしません。

FIPS システム全体の暗号化ポリシーは、より高いレベルの制限を設定するのに役立ちます。したがって、暗号化の俊敏性をサポートする通信プロトコルは、選択時にシステムが拒否する暗号をアナウンスしません。たとえば、ChaCha20 アルゴリズムは FIPS によって承認されておらず、FIPS 暗号化ポリシーは、TLS サーバーおよびクライアントが TLS_ECDHE_ECDSA_WITH_CHACHA20_POLY1305_SHA256 TLS 暗号スイートをアナウンスしないようにします。これは、そのような暗号を使用しようとすると失敗するためです。

RHEL を FIPS モードで操作し、独自の FIPS モード関連の設定オプションを提供するアプリケーションを使用する場合は、これらのオプションと対応するアプリケーションのガイダンスを無視してください。FIPS モードで実行されているシステムとシステム全体の暗号化ポリシーは、FIPS 準拠の暗号化のみを適用します。たとえば、システムが FIPS モードで実行されている場合、Node.js 設定オプション --enable-fips は無視されます。FIPS モードで実行されていないシステムで --enable-fips オプションを使用すると、FIPS-140 準拠の要件を満たせなくなります。

FIPS モードの RHEL 8.6 (およびそれ以降) カーネルは、FIPS 140-3 に準拠するように設計されていますが、まだ米国国立標準技術研究所 (NIST) 暗号モジュール検証プログラム (CMVP) によって認定されていません。最新の認定カーネルモジュールは、RHSA-2021:4356 アドバイザリー更新後の更新された RHEL 8.5 カーネルです。この認定は FIPS 140-2 標準に適用されます。暗号化モジュールが FIPS 140-2 または 140-3 のどちらに準拠するかを選択することはできません。Compliance Activities and Government Standards ナレッジベース記事の FIPS 140-2 and FIPS 140-3 セクションでは、選択した RHEL マイナーリリースにおける暗号化モジュールの検証ステータスの概要が説明されています。

2.2. FIPS モードが有効なシステムのインストール

連邦情報処理規格 (FIPS) 140 で義務付けられている暗号化モジュールの自己チェックを有効にするには、システムのインストール時に FIPS モードを有効にします。

RHEL のインストール中に FIPS モードを有効にするだけで、システムは FIPS で承認されるアルゴリズムと継続的な監視テストですべての鍵を生成するようになります。

手順

-

システムのインストール時に

fips=1オプションをカーネルコマンドラインに追加します。 - ソフトウェアの選択段階で、サードパーティーのソフトウェアをインストールしないでください。

- インストール後に、システムは FIPS モードで自動的に起動します。

検証

システムが起動したら、FIPS モードが有効になっていることを確認します。

$ fips-mode-setup --check FIPS mode is enabled.

関連情報

- 高度な RHEL インストールの実行ドキュメントの 起動オプションの編集 セクション

2.3. 関連情報

第3章 システム全体の暗号化ポリシーの使用

システム全体の暗号化ポリシーは、コア暗号化サブシステムを設定するシステムコンポーネントで、TLS、IPsec、SSH、DNSSec、および Kerberos の各プロトコルに対応します。これにより、管理者が選択できる小規模セットのポリシーを提供します。

3.1. システム全体の暗号化ポリシー

システム全体のポリシーを設定すると、RHEL のアプリケーションはそのポリシーに従い、ポリシーを満たしていないアルゴリズムやプロトコルを使用するように明示的に要求されない限り、その使用を拒否します。つまり、システムが提供した設定で実行する際に、デフォルトのアプリケーションの挙動にポリシーを適用しますが、必要な場合は上書きできます。

RHEL 8 には、以下の定義済みポリシーが含まれています。

DEFAULT- デフォルトのシステム全体の暗号化ポリシーレベルで、現在の脅威モデルに対して安全なものです。TLS プロトコルの 1.2 と 1.3、IKEv2 プロトコル、および SSH2 プロトコルが使用できます。RSA 鍵と Diffie-Hellman パラメーターは長さが 2048 ビット以上であれば許容されます。

LEGACY-

Red Hat Enterprise Linux 5 以前との互換性を最大限に確保します。攻撃対象領域が増えるため、セキュリティーが低下します。

DEFAULTレベルでのアルゴリズムとプロトコルに加えて、TLS プロトコル 1.0 および 1.1 を許可します。アルゴリズム DSA、3DES、および RC4 が許可され、RSA 鍵と Diffie-Hellman パラメーターの長さが 1023 ビット以上であれば許容されます。 FUTURE- 将来の潜在的なポリシーをテストすることを目的とした、より厳格な将来を見据えたセキュリティーレベル。このポリシーでは、署名アルゴリズムでの SHA-1 の使用は許可されません。TLS プロトコルの 1.2 と 1.3、IKEv2 プロトコル、および SSH2 プロトコルが使用できます。RSA 鍵と Diffie-Hellman パラメーターは、ビット長が 3072 以上だと許可されます。システムが公共のインターネット上で通信する場合、相互運用性の問題が発生する可能性があります。

FIPS-

FIPS 140 要件に準拠します。RHEL システムを FIPS モードに切り替える

fips-mode-setupツールは、このポリシーを内部的に使用します。FIPSポリシーに切り替えても、FIPS 140 標準への準拠は保証されません。また、システムを FIPS モードに設定した後、すべての暗号キーを再生成する必要があります。多くのシナリオでは、これは不可能です。

Red Hat は、LEGACY ポリシーを使用する場合を除き、すべてのライブラリーがセキュアなデフォルト値を提供するように、すべてのポリシーレベルを継続的に調整します。LEGACY プロファイルはセキュアなデフォルト値を提供しませんが、このプロファイルには、簡単に悪用できるアルゴリズムは含まれていません。このため、提供されたポリシーで有効なアルゴリズムのセットまたは許容可能な鍵サイズは、Red Hat Enterprise Linux の存続期間中に変更する可能性があります。

このような変更は、新しいセキュリティー標準や新しいセキュリティー調査を反映しています。Red Hat Enterprise Linux のライフサイクル全体にわたって特定のシステムとの相互運用性を確保する必要がある場合は、そのシステムと対話するコンポーネントのシステム全体の暗号化ポリシーからオプトアウトするか、カスタム暗号化ポリシーを使用して特定のアルゴリズムを再度有効にする必要があります。

カスタマーポータル API の証明書が使用する暗号化鍵は FUTURE のシステム全体の暗号化ポリシーが定義する要件を満たさないので、現時点で redhat-support-tool ユーティリティーは、このポリシーレベルでは機能しません。

この問題を回避するには、カスタマーポータル API への接続中に DEFAULT 暗号化ポリシーを使用します。

ポリシーレベルで許可されていると記載されている特定のアルゴリズムと暗号は、アプリケーションがそれらをサポートしている場合にのみ使用できます。

暗号化ポリシーを管理するためのツール

現在のシステム全体の暗号化ポリシーを表示または変更するには、update-crypto-policies ツールを使用します。以下に例を示します。

$ update-crypto-policies --show DEFAULT # update-crypto-policies --set FUTURE Setting system policy to FUTURE

暗号化ポリシーの変更を確実に適用するには、システムを再起動します。

安全でない暗号スイートとプロトコルを削除することによる強力な暗号デフォルト

以下の一覧には、RHEL のコア暗号化ライブラリーから削除された暗号スイートおよびプロトコルが含まれます。この暗号スイートおよびプロトコルは、ソースに存在しないか、ビルド時にそのサポートが無効になっているため、アプリケーションはこれらを使用できません。

- DES (RHEL 7 以降)

- すべてのエクスポートグレードの暗号化スイート (RHEL 7 以降)

- 署名内の MD5 (RHEL 7 以降)

- SSLv2 (RHEL 7 以降)

- SSLv3 (RHEL 8 以降)

- 224 ビットより小さいすべての ECC 曲線 (RHEL 6 以降)

- すべてのバイナリーフィールドの ECC 曲線 (RHEL 6 以降)

すべてのポリシーレベルで無効になっている暗号スイートおよびプロトコル

次の暗号スイートとプロトコルは、すべての暗号化ポリシーで無効になっています。これは、各アプリケーションで明示的に有効にした場合に限り利用可能にできます。

- パラメーターが 1024 ビットより小さい DH

- 鍵のサイズが 1024 ビットより小さい RSA

- Camellia

- ARIA

- SEED

- IDEA

- 完全性のみの暗号スイート

- SHA-384 HMAC を使用した TLS CBC モード暗号化スイート

- AES-CCM8

- TLS 1.3 と互換性がないすべての ECC 曲線 (secp256k1 を含む)

- IKEv1 (RHEL 8 以降)

暗号化ポリシーで有効になっている暗号スイートとプロトコル

各暗号化ポリシーでは、特定の暗号スイートとプロトコルが有効になっています。

LEGACY | DEFAULT | FIPS | FUTURE | |

|---|---|---|---|---|

| IKEv1 | いいえ | いいえ | いいえ | いいえ |

| 3DES | はい | いいえ | いいえ | いいえ |

| RC4 | はい | いいえ | いいえ | いいえ |

| DH | 最低 1024 ビット | 最低 2048 ビット | 最低 2048 ビット[a] | 最低 3072 ビット |

| RSA | 最低 1024 ビット | 最低 2048 ビット | 最低 2048 ビット | 最低 3072 ビット |

| DSA | はい | いいえ | いいえ | いいえ |

| TLS v1.0 | はい | いいえ | いいえ | いいえ |

| TLS v1.1 | はい | いいえ | いいえ | いいえ |

| デジタル署名における SHA-1 | はい | はい | いいえ | いいえ |

| CBC モード暗号 | はい | はい | はい | いいえ[b] |

| 256 ビットより小さい鍵を持つ対称暗号 | はい | はい | はい | いいえ |

| 証明書における SHA-1 および SHA-224 の署名 | はい | はい | はい | いいえ |

[a]

RFC 7919 および RFC 3526 で定義されている Diffie-Hellman グループのみを使用できます。

[b]

TLS の CBC 暗号が無効になっています。TLS 以外のシナリオでは、 AES-128-CBC は無効になっていますが、AES-256-CBC が有効になります。AES-256-CBC も無効にするには、カスタムのサブポリシーを適用します。

| ||||

関連情報

-

update-crypto-policies(8)の man ページ

3.2. システム全体の暗号化ポリシーを、以前のリリースと互換性のあるモードに切り替え

Red Hat Enterprise Linux 8 におけるデフォルトのシステム全体の暗号化ポリシーでは、現在は古くて安全ではないプロトコルは許可されません。Red Hat Enterprise Linux 6 およびそれ以前のリリースとの互換性が必要な場合には、安全でない LEGACY ポリシーレベルを利用できます。

LEGACY ポリシーレベルに設定すると、システムおよびアプリケーションの安全性が低下します。

手順

システム全体の暗号化ポリシーを

LEGACYレベルに切り替えるには、rootで以下のコマンドを実行します。# update-crypto-policies --set LEGACY Setting system policy to LEGACY

関連情報

-

利用可能な暗号化ポリシーのレベルは、

update-crypto-policies(8)の man ページを参照してください。 -

カスタム暗号化ポリシーの定義については、man ページの

update-crypto-policies (8)のCustom Policiesセクションと、crypto-policies(7)のCrypto Policy Definition Formatセクションを参照してください。

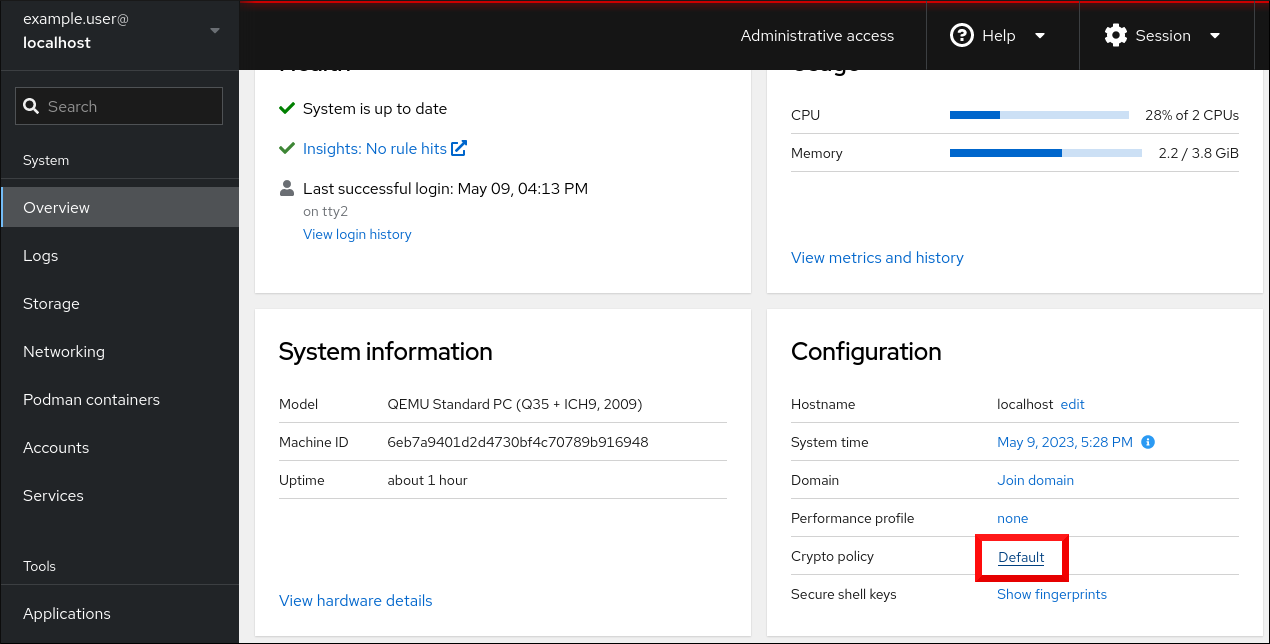

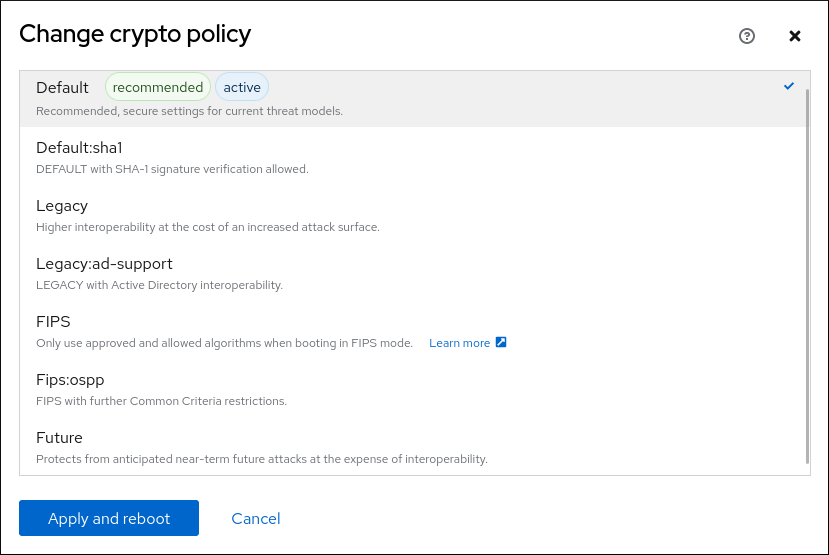

3.3. Web コンソールでシステム全体の暗号化ポリシーを設定する

RHEL Web コンソールインターフェイスで、システム全体の暗号化ポリシーとサブポリシーのいずれかを直接設定できます。4 つの事前定義されたシステム全体の暗号化ポリシーに加え、グラフィカルインターフェイスを介して、次のポリシーとサブポリシーの組み合わせを適用することもできます。

DEFAULT:SHA1-

SHA-1アルゴリズムが有効になっているDEFAULTポリシー。 LEGACY:AD-SUPPORT-

Active Directory サービスの相互運用性を向上させる、セキュリティーの低い設定を含む

LEGACYポリシー。 FIPS:OSPP-

Common Criteria for Information Technology Security Evaluation 標準の影響を受けて策定された、さらなる制限を含む

FIPSポリシー。

前提条件

- RHEL 8 Web コンソールがインストールされている。詳細は、Web コンソールのインストールおよび有効化 を参照してください。

-

sudoを使用して管理コマンドを入力するための root権限または権限がある。

手順

- Web コンソールにログインします。詳細は、Web コンソールへのログイン を参照してください。

Overview ページの Configuration カードで、Crypto policy の横にある現在のポリシー値をクリックします。

Change crypto policy ダイアログウィンドウで、システムで使用を開始するポリシーをクリックします。

- Apply and reboot ボタンをクリックします。

検証

-

再起動後、Web コンソールに再度ログインし、暗号化ポリシー の値が選択したものと一致していることを確認します。あるいは、

update-crypto-policies --showコマンドを入力して、現在のシステム全体の暗号化ポリシーをターミナルに表示することもできます。

3.4. FIPS モードへのシステムの切り替え

システム全体の暗号化ポリシーには、連邦情報処理標準 (FIPS) Publication 140 の要件に従って暗号化アルゴリズムを有効にするポリシーレベルが含まれています。FIPS モードを有効または無効にする fips-mode-setup ツールは、内部的に FIPS のシステム全体の暗号化ポリシーを使用します。

FIPS システム全体の暗号化ポリシーを使用してシステムを FIPS モードに切り替えても、FIPS 140 標準への準拠は保証されません。システムを FIPS モードに設定した後にすべての暗号キーを再生成することは、可能でない場合があります。たとえば、ユーザーの暗号キーを含む既存の IdM レルムの場合、すべてのキーを再生成することはできません。

fips-mode-setup ツールは、FIPS ポリシーを内部的に使用します。ただし、--set FIPS オプションを指定した update-crypto-policies コマンドが実行する内容に加え、fips-mode-setup は、fips-finish-install ツールを使用して FIPS dracut モジュールを確実にインストールします。また、fips=1 ブートオプションをカーネルコマンドラインに追加し、初期 RAM ディスクを再生成します。

RHEL のインストール中に FIPS モード を有効にするだけで、システムは FIPS で承認されるアルゴリズムと継続的な監視テストですべてのキーを生成するようになります。

手順

システムを FIPS モードに切り替えるには、以下のコマンドを実行します。

# fips-mode-setup --enable Kernel initramdisks are being regenerated. This might take some time. Setting system policy to FIPS Note: System-wide crypto policies are applied on application start-up. It is recommended to restart the system for the change of policies to fully take place. FIPS mode will be enabled. Please reboot the system for the setting to take effect.システムを再起動して、カーネルを FIPS モードに切り替えます。

# reboot

検証

システムが再起動したら、FIPS モードの現在の状態を確認できます。

# fips-mode-setup --check FIPS mode is enabled.

関連情報

-

FIPS-mode-setup(8)の man ページ - FIPS モードが有効な RHEL 8 システムのインストール

- List of RHEL applications using cryptography that is not compliant with FIPS 140-2

- NIST (National Institute of Standards and Technology) の Web サイトの Security Requirements for Cryptographic Modules。

3.5. コンテナーでの FIPS モードの有効化

Federal Information Processing Standard Publication 140-2 (FIPS モード) で義務付けられている暗号化モジュールのセルフチェックの完全なセットを有効にするには、ホストシステムのカーネルが FIPS モードで実行されている必要があります。ホストシステムのバージョンに応じて、コンテナーで FIPS モードを有効にすることが完全に自動で行われるか、コマンドが 1 つだけ必要になります。

コンテナーで fips-mode-setup コマンドが正しく機能せず、このシナリオでこのコマンドを使用して FIPS モードを有効にしたり確認することができません。

前提条件

- ホストシステムが FIPS モードである必要があります。

手順

RHEL 8.1 および 8.2 を実行しているホストの場合: 次のコマンドを使用してコンテナー内の FIPS 暗号化ポリシーレベルを設定し、

fips-mode-setupコマンドを使用するというアドバイスは無視します。$ update-crypto-policies --set FIPS-

RHEL 8.4 以降を実行しているホスト: FIPS モードが有効になっているシステムでは、

podmanユーティリティーはサポートされているコンテナーで FIPS モードを自動的に有効にします。

3.6. List of RHEL applications using cryptography that is not compliant with FIPS 140-2

FIPS 140 などの関連するすべての暗号化認定に合格するには、コア暗号化コンポーネントセットのライブラリーを使用します。これらのライブラリーは、libgcrypt を除き、RHEL システム全体の暗号化ポリシーに従います。

コア暗号化コンポーネントの概要、そのコンポーネントの選択方法、オペレーティングシステムへの統合方法、ハードウェアセキュリティーモジュールおよびスマートカードのサポート方法、暗号化による認定の適用方法の概要は、RHEL コア crypto コンポーネント の記事を参照してください。

以下の表に加えて、一部の RHEL 8 Z-stream リリース (例: 8.1.1) では Firefox ブラウザーパッケージが更新され、別の NSS 暗号化ライブラリーが含まれています。このように、Red Hat では、パッチリリースでこのような詳細レベルのコンポーネントをリベースするなどの混乱を回避できればと考えています。そのため、この Firefox パッケージは FIPS 140-2 検証モジュールを使用しません。

FIPS 140-2 に準拠していない暗号化を使用する RHEL 8 アプリケーションのリスト

- FreeRADIUS

- MD5 を使用する RADIUS プロトコル。

- Ghostscript

- ドキュメントを暗号化および復号化するためのカスタムの cryptogtaphy 実装 (MD5、RC4、SHA-2、AES)

- iPXE

- TLS の暗号スタックはコンパイルされていますが、使用されません。

- Libica

- CPACF 命令から RSA や ECDH などのさまざまなアルゴリズムのソフトウェアフォールバック。

- OVMF (UEFI ファームウェア)、Edk2、shim

- 完全な暗号スタック (OpenSSL ライブラリーの埋め込みコピー)。

- Perl

- HMAC、HMAC-SHA1、HMAC-MD5、SHA-1、SHA-224 など

- Pidgin

- DES と RC4 を実装します。

- QAT エンジン

- 暗号化プリミティブのハードウェアおよびソフトウェア実装 (RSA、EC、DH、AES など)。

- Samba [2]

- AES、DES、および RC4 を実装します。

- Valgrind

- AES、ハッシュ [3]

関連情報

- ナレッジベース記事 コンプライアンス活動と政府標準 の FIPS 140-2 and FIPS 140-3 セクション

- ナレッジベース記事 RHEL core cryptographic components

3.7. システム全体の暗号化ポリシーに従わないようにアプリケーションを除外

アプリケーションで使用される暗号化関連の設定をカスタマイズする必要がある場合は、サポートされる暗号スイートとプロトコルをアプリケーションで直接設定することが推奨されます。

/etc/crypto-policies/back-ends ディレクトリーからアプリケーション関連のシンボリックリンクを削除することもできます。カスタマイズした暗号化設定に置き換えることもできます。この設定により、除外されたバックエンドを使用するアプリケーションに対するシステム全体の暗号化ポリシーが使用できなくなります。この修正は、Red Hat ではサポートされていません。

3.7.1. システム全体の暗号化ポリシーを除外する例

wget

wget ネットワークダウンローダーで使用される暗号化設定をカスタマイズするには、--secure-protocol オプションおよび --ciphers オプションを使用します。以下に例を示します。

$ wget --secure-protocol=TLSv1_1 --ciphers="SECURE128" https://example.com

詳細は、wget(1) man ページの HTTPS (SSL/TLS) Options のセクションを参照してください。

curl

curl ツールで使用する暗号を指定するには、--ciphers オプションを使用して、その値に、コロンで区切った暗号化のリストを指定します。以下に例を示します。

$ curl https://example.com --ciphers '@SECLEVEL=0:DES-CBC3-SHA:RSA-DES-CBC3-SHA'

詳細は、curl(1) の man ページを参照してください。

Firefox

Web ブラウザーの Firefox でシステム全体の暗号化ポリシーをオプトアウトできない場合でも、Firefox の設定エディターで、対応している暗号と TLS バージョンをさらに詳細に制限できます。アドレスバーに about:config と入力し、必要に応じて security.tls.version.min の値を変更します。たとえば、security.tls.version.min を 1 に設定すると、最低でも TLS 1.0 が必要になり、security.tls.version.min 2 が TLS 1.1 になります。

OpenSSH

OpenSSH サーバーに対するシステム全体の暗号化ポリシーを除外するには、/etc/sysconfig/sshd ファイルの CRYPTO_POLICY= 変数行のコメントを除外します。この変更後、/etc/ssh/sshd_config ファイルの Ciphers セクション、MACs セクション、KexAlgoritms セクション、および GSSAPIKexAlgorithms セクションで指定した値は上書きされません。

詳細は、sshd_config(5) の man ページを参照してください。

OpenSSH クライアントのシステム全体の暗号化ポリシーをオプトアウトするには、次のいずれかのタスクを実行します。

-

指定のユーザーの場合は、

~/.ssh/configファイルのユーザー固有の設定でグローバルのssh_configを上書きします。 -

システム全体の場合は、

/etc/ssh/ssh_config.d/ディレクトリーにあるドロップイン設定ファイルに暗号化ポリシーを指定します。このとき、辞書式順序で05-redhat.confファイルよりも前に来るように、5 未満の 2 桁の接頭辞と、.confという接尾辞を付けます (例:04-crypto-policy-override.conf)。

詳細は、ssh_config(5) の man ページを参照してください。

Libreswan

詳細は、ネットワークのセキュリティー保護 の システム全体の暗号化ポリシーをオプトアウトする IPsec 接続の設定 を参照してください。

関連情報

-

update-crypto-policies(8)の man ページ

3.8. サブポリシーを使用したシステム全体の暗号化ポリシーのカスタマイズ

この手順を使用して、有効な暗号化アルゴリズムまたはプロトコルのセットを調整します。

既存のシステム全体の暗号化ポリシーの上にカスタムサブポリシーを適用するか、そのようなポリシーを最初から定義することができます。

スコープが設定されたポリシーの概念により、バックエンドごとに異なるアルゴリズムセットを有効にできます。各設定ディレクティブは、特定のプロトコル、ライブラリー、またはサービスに限定できます。

また、ディレクティブでは、ワイルドカードを使用して複数の値を指定する場合にアスタリスクを使用できます。

/etc/crypto-policies/state/CURRENT.pol ファイルには、ワイルドカードデプロイメント後に現在適用されているシステム全体の暗号化ポリシーのすべての設定がリスト表示されます。暗号化ポリシーをより厳密にするには、/usr/share/crypto-policies/policies/FUTURE.pol ファイルにリストされている値を使用することを検討してください。

サブポリシーの例は、/usr/share/crypto-policies/policies/modules/ ディレクトリーにあります。このディレクトリーのサブポリシーファイルには、コメントアウトされた行に説明が含まれています。

システム全体の暗号化ポリシーのカスタマイズは、RHEL 8.2 から利用できます。スコープ指定ポリシーの概念と、RHEL 8.5 以降でワイルドカードを使用するオプションを使用できます。

手順

/etc/crypto-policies/policies/modules/ディレクトリーをチェックアウトします。# cd /etc/crypto-policies/policies/modules/調整用のサブポリシーを作成します。次に例を示します。

# touch MYCRYPTO-1.pmod # touch SCOPES-AND-WILDCARDS.pmod

重要ポリシーモジュールのファイル名には大文字を使用します。

任意のテキストエディターでポリシーモジュールを開き、システム全体の暗号化ポリシーを変更するオプションを挿入します。次に例を示します。

# vi MYCRYPTO-1.pmodmin_rsa_size = 3072 hash = SHA2-384 SHA2-512 SHA3-384 SHA3-512

# vi SCOPES-AND-WILDCARDS.pmod# Disable the AES-128 cipher, all modes cipher = -AES-128-* # Disable CHACHA20-POLY1305 for the TLS protocol (OpenSSL, GnuTLS, NSS, and OpenJDK) cipher@TLS = -CHACHA20-POLY1305 # Allow using the FFDHE-1024 group with the SSH protocol (libssh and OpenSSH) group@SSH = FFDHE-1024+ # Disable all CBC mode ciphers for the SSH protocol (libssh and OpenSSH) cipher@SSH = -*-CBC # Allow the AES-256-CBC cipher in applications using libssh cipher@libssh = AES-256-CBC+

- 変更をモジュールファイルに保存します。

ポリシーの調整を、システム全体の暗号化ポリシーレベル

DEFAULTに適用します。# update-crypto-policies --set DEFAULT:MYCRYPTO-1:SCOPES-AND-WILDCARDS暗号化設定を実行中のサービスやアプリケーションで有効にするには、システムを再起動します。

# reboot

検証

/etc/crypto-policies/state/CURRENT.polファイルに変更が含まれていることを確認します。以下に例を示します。$ cat /etc/crypto-policies/state/CURRENT.pol | grep rsa_size min_rsa_size = 3072

関連情報

-

update-crypto-policies(8)man ページのCustom Policiesセクション -

crypto-policies(7)man ページのCrypto Policy Definition Formatセクション - Red Hat ブログ記事 How to customize crypto policies in RHEL 8.2

3.9. システム全体の暗号化ポリシーをカスタマイズして SHA-1 を無効化

SHA-1 ハッシュ関数は本質的に設計面で弱く、暗号解析機能によって攻撃を受けやすいため、RHEL 8 ではデフォルトで SHA-1 を使用していません。ただし、一部のサードパーティーアプリケーション (公開署名など) は SHA-1 を使用します。システムの署名アルゴリズムで SHA-1 の使用を無効にするには、NO-SHA1 ポリシーモジュールを使用できます。

NO-SHA1 ポリシーモジュールが無効にするのは、署名の SHA-1 ハッシュ関数だけでそれ以外は無効になりません。特に、NO-SHA1 モジュールでも、ハッシュベースのメッセージ認証コード (HMAC) とともに SHA-1 を使用できます。HMAC セキュリティープロパティーは、対応するハッシュ関数の衝突耐性に依存しないので、HMAC に SHA-1 を使用している場合に最近の SHA-1 への攻撃による影響は大幅に低くなっています。

特定の鍵交換 (KEX) アルゴリズムの組み合わせ (例: diffie-hellman-group-exchange-sha1) を無効にする必要があるものの、関連する KEX とアルゴリズムの両方を継続して使用する場合は、SSH のシステム全体の暗号化ポリシーをオプトアウトして SSH を直接設定する手順について、SSH で diffie-hellman-group1-sha1 アルゴリズムを無効にする手順 を参照してください。

SHA-1 を無効にするモジュールは、RHEL 8.3 で利用できます。システム全体の暗号化ポリシーのカスタマイズは、RHEL 8.2 から利用できます。

手順

ポリシーの調整を、システム全体の暗号化ポリシーレベル

DEFAULTに適用します。# update-crypto-policies --set DEFAULT:NO-SHA1暗号化設定を実行中のサービスやアプリケーションで有効にするには、システムを再起動します。

# reboot

関連情報

-

update-crypto-policies(8)man ページのCustom Policiesセクション -

crypto-policies(7)man ページのCrypto Policy Definition Formatセクション - Red Hat ブログ記事 How to customize crypto policies in RHEL

3.10. システム全体のカスタム暗号化ポリシーの作成および設定

以下の手順は、完全なポリシーファイルでシステム全体の暗号化ポリシーをカスタマイズする方法を示しています。

システム全体の暗号化ポリシーのカスタマイズは、RHEL 8.2 から利用できます。

手順

カスタマイズのポリシーファイルを作成します。

# cd /etc/crypto-policies/policies/ # touch MYPOLICY.pol

または、定義されている 4 つのポリシーレベルのいずれかをコピーします。

# cp /usr/share/crypto-policies/policies/DEFAULT.pol /etc/crypto-policies/policies/MYPOLICY.pol必要に応じて、テキストエディターでファイルを編集します。以下のようにしてカスタム暗号化ポリシーを使用します。

# vi /etc/crypto-policies/policies/MYPOLICY.polシステム全体の暗号化ポリシーをカスタムレベルに切り替えます。

# update-crypto-policies --set MYPOLICY暗号化設定を実行中のサービスやアプリケーションで有効にするには、システムを再起動します。

# reboot

関連情報

-

update-crypto-policies (8)の man ページのCustom Policiesセクションと、crypto-policies(7)のCrypto Policy Definition Formatセクションを参照してください。 - Red Hat ブログ記事 How to customize crypto policies in RHEL

3.11. 関連情報

第4章 crypto_policies RHEL システムロールを使用したカスタム暗号化ポリシーの設定

管理者は、crypto_policies RHEL システムロール を使用して、Ansible Core パッケージを使用し、多くの異なるシステムでカスタム暗号化ポリシーを迅速かつ一貫して設定できます。

4.1. crypto_policies システムロール変数およびファクト

Ccrypto_policies システムロール Playbook では、設定および制限に合わせて、crypto_policies 設定ファイルのパラメーターを定義できます。

変数を設定しない場合には、システムロールではシステムが設定されず、ファクトのみが報告されます。

crypto_policies システムロールの一部の変数

crypto_policies_policy- 管理対象ノードにシステムロールを適用する暗号化ポリシーを決定します。異なる暗号化ポリシーの詳細は、システム全体の暗号化ポリシー を参照してください。

crypto_policies_reload-

yesに設定すると、暗号化ポリシーの適用後に、影響を受けるサービス (現在ipsec、バインド、およびsshdサービス) でリロードされます。デフォルトはyesです。 crypto_policies_reboot_ok-

yesに設定されており、システムロールで暗号化ポリシーを変更した後に再起動が必要な場合には、crypto_policies_reboot_requiredをyesに設定します。デフォルトはnoです。

crypto_policies システムロールにより設定されるファクト

crypto_policies_active- 現在選択されているポリシーをリスト表示します。

crypto_policies_available_policies- システムで利用可能なすべてのポリシーを表示します。

crypto_policies_available_subpolicies- システムで利用可能なすべてのサブポリシーを表示します。

4.2. crypto_policies システムロールを使用したカスタム暗号化ポリシーの設定

crypto_policies システムロールを使用して、単一のコントロールノードから多数の管理対象ノードを一貫して設定できます。

前提条件

- 制御ノードと管理ノードを準備している

- 管理対象ノードで Playbook を実行できるユーザーとしてコントロールノードにログインしている。

-

管理対象ノードへの接続に使用するアカウントには、そのノードに対する

sudo権限がある。 - この Playbook を実行する管理対象ノードまたは管理対象ノードのグループが、Ansible インベントリーファイルにリストされている。

手順

~/crypto-playbook.ymlなどの Playbook ファイルを次の内容で作成します。--- - hosts: all tasks: - name: Configure crypto policies include_role: name: rhel-system-roles.crypto_policies vars: - crypto_policies_policy: FUTURE - crypto_policies_reboot_ok: trueFUTURE の値は、任意の暗号化ポリシー (例:

DEFAULT、LEGACY、およびFIPS:OSPP) に置き換えることができます。crypto_policies_reboot_ok: true変数を設定すると、システムロールで暗号化ポリシーを変更した後にシステムが再起動されます。詳細は、crypto_policies システムロールの変数と事実 を参照してください。

Playbook の構文を検証します。

# ansible-playbook ~/crypto-playbook.yml --syntax-checkこのコマンドは構文を検証するだけであり、有効だが不適切な設定から保護するものではないことに注意してください。

インベントリーファイルで Playbook を実行します。

# ansible-playbook ~/crypto-playbook.yml

検証

コントロールノードで、たとえば

verify_playbook.ymlという名前の別の Playbook を作成します。- hosts: all tasks: - name: Verify active crypto policy include_role: name: rhel-system-roles.crypto_policies - debug: var: crypto_policies_activeこの Playbook では、システムの設定は変更されず、マネージドノードのアクティブなポリシーだけを報告します。

同じインベントリーファイルで Playbook を実行します。

# ansible-playbook verify_playbook.yml TASK [debug] ************************** ok: [host] => { "crypto_policies_active": "FUTURE" }

"crypto_policies_active":変数は、マネージドノードでアクティブなポリシーを表示します。

4.3. 関連情報

-

/usr/share/ansible/roles/rhel-system-roles.crypto_policies/README.mdファイル -

ansible-playbook(1)の man ページ。 - RHEL System Roles を使用するための制御ノードと管理対象ノードの準備

第5章 PKCS #11 で暗号化ハードウェアを使用するようにアプリケーションを設定

スマートカードや、エンドユーザー認証用の暗号化トークン、サーバーアプリケーション用のハードウェアセキュリティーモジュール (HSM) など、専用の暗号化デバイスで秘密情報の一部を分離することで、セキュリティー層が追加されます。RHEL では、PKCS #11 API を使用した暗号化ハードウェアへの対応がアプリケーション間で統一され、暗号ハードウェアでの秘密の分離が複雑なタスクではなくなりました。

5.1. PKCS #11 による暗号化ハードウェアへの対応

Public-Key Cryptography Standard (PKCS) #11 は、暗号化情報を保持し、暗号化機能を実行する暗号化デバイスへのアプリケーションプログラミングインターフェイス (API) を定義します。

PKCS #11 では、各ハードウェアまたはソフトウェアデバイスを統一された方法でアプリケーションに提示するオブジェクトである 暗号化トークン が導入されています。したがって、アプリケーションは、通常はユーザーによって使用されるスマートカードなどのデバイスや、通常はコンピューターによって使用されるハードウェアセキュリティーモジュールを PKCS #11 暗号化トークンとして認識します。

PKCS #11 トークンには、証明書、データオブジェクト、公開鍵、秘密鍵、または秘密鍵を含むさまざまなオブジェクトタイプを保存できます。これらのオブジェクトは、PKCS #11 Uniform Resource Identifier (URI) スキームを通じて一意に識別できます。

PKCS #11 の URI は、オブジェクト属性に従って、PKCS #11 モジュールで特定のオブジェクトを識別する標準的な方法です。これにより、URI の形式で、すべてのライブラリーとアプリケーションを同じ設定文字列で設定できます。

RHEL では、デフォルトでスマートカード用に OpenSC PKCS #11 ドライバーが提供されています。ただし、ハードウェアトークンと HSM には、システムにカウンターパートを持たない独自の PKCS #11 モジュールがあります。この PKCS #11 モジュールは p11-kit ツールで登録できます。これは、システムの登録済みスマートカードドライバーにおけるラッパーとして機能します。

システムで独自の PKCS #11 モジュールを有効にするには、新しいテキストファイルを /etc/pkcs11/modules/ ディレクトリーに追加します。

/etc/pkcs11/modules/ ディレクトリーに新しいテキストファイルを作成すると、独自の PKCS #11 モジュールをシステムに追加できます。たとえば、p11-kit の OpenSC 設定ファイルは、以下のようになります。

$ cat /usr/share/p11-kit/modules/opensc.module

module: opensc-pkcs11.so5.2. スマートカードに保存された SSH 鍵の使用

Red Hat Enterprise Linux では、OpenSSH クライアントでスマートカードに保存されている RSA 鍵および ECDSA 鍵を使用できるようになりました。この手順に従って、パスワードの代わりにスマートカードを使用した認証を有効にします。

前提条件

-

クライアントで、

openscパッケージをインストールして、pcscdサービスを実行している。

手順

PKCS #11 の URI を含む OpenSC PKCS #11 モジュールが提供する鍵のリストを表示し、その出力を keys.pub ファイルに保存します。

$ ssh-keygen -D pkcs11: > keys.pub $ ssh-keygen -D pkcs11: ssh-rsa AAAAB3NzaC1yc2E...KKZMzcQZzx pkcs11:id=%02;object=SIGN%20pubkey;token=SSH%20key;manufacturer=piv_II?module-path=/usr/lib64/pkcs11/opensc-pkcs11.so ecdsa-sha2-nistp256 AAA...J0hkYnnsM= pkcs11:id=%01;object=PIV%20AUTH%20pubkey;token=SSH%20key;manufacturer=piv_II?module-path=/usr/lib64/pkcs11/opensc-pkcs11.so

リモートサーバー (example.com) でスマートカードを使用した認証を有効にするには、公開鍵をリモートサーバーに転送します。前の手順で作成された keys.pub で

ssh-copy-idコマンドを使用します。$ ssh-copy-id -f -i keys.pub username@example.com手順 1 の

ssh-keygen -Dコマンドの出力にある ECDSA 鍵を使用して example.com に接続するには、鍵を一意に参照する URI のサブセットのみを使用できます。以下に例を示します。$ ssh -i "pkcs11:id=%01?module-path=/usr/lib64/pkcs11/opensc-pkcs11.so" example.com Enter PIN for 'SSH key': [example.com] $~/.ssh/configファイルで同じ URI 文字列を使用して、設定を永続化できます。$ cat ~/.ssh/config IdentityFile "pkcs11:id=%01?module-path=/usr/lib64/pkcs11/opensc-pkcs11.so" $ ssh example.com Enter PIN for 'SSH key': [example.com] $

OpenSSH は

p11-kit-proxyラッパーを使用し、OpenSC PKCS #11 モジュールが PKCS#11 キットに登録されているため、以前のコマンドを簡素化できます。$ ssh -i "pkcs11:id=%01" example.com Enter PIN for 'SSH key': [example.com] $

PKCS #11 の URI の id= の部分を飛ばすと、OpenSSH が、プロキシーモジュールで利用可能な鍵をすべて読み込みます。これにより、必要な入力の量を減らすことができます。

$ ssh -i pkcs11: example.com

Enter PIN for 'SSH key':

[example.com] $関連情報

- Fedora 28: Better smart card support in OpenSSH

-

p11-kit(8)、opensc.conf(5)、pcscd(8)、ssh(1)、およびssh-keygen(1)の man ページ

5.3. スマートカード上の証明書を使用して認証するアプリケーションの設定

アプリケーションでスマートカードを使用して認証することにより、セキュリティーが強化され、自動化が簡素化される場合があります。次の方法を使用して、Public Key Cryptography Standard (PKCS) #11 URI をアプリケーションに統合できます。

-

FirefoxWeb ブラウザーは、p11-kit-proxyPKCS #11 モジュールを自動的にロードします。つまり、システムで対応しているすべてのスマートカードが自動的に検出されます。TLS クライアント認証を使用する場合、追加のセットアップは必要ありません。サーバーが要求したときにスマートカードの鍵と証明書が自動的に使用されます。 -

アプリケーションが

GnuTLSまたはNSSライブラリーを使用している場合、PKCS #11 URI はすでにサポートされています。また、OpenSSLライブラリーに依存するアプリケーションは、openssl-pkcs11パッケージによって提供されるpkcs11エンジンを通じて、スマートカードを含む暗号化ハードウェアモジュールにアクセスできます。 -

スマートカード上の秘密鍵を操作する必要があり、

NSS、GnuTLS、OpenSSLを使用しないアプリケーションは、特定の PKCS #11 モジュールの PKCS #11 API を使用するのではなく、p11-kitAPI を直接使用して、スマートカードを含む暗号化ハードウェアモジュールを操作できます。 wgetネットワークダウンローダーを使用すると、ローカルに保存された秘密鍵と証明書へのパスの代わりに PKCS #11 URI を指定できます。これにより、安全に保管された秘密鍵と証明書を必要とするタスクのスクリプトの作成が簡素化される可能性があります。以下に例を示します。$ wget --private-key 'pkcs11:token=softhsm;id=%01;type=private?pin-value=111111' --certificate 'pkcs11:token=softhsm;id=%01;type=cert' https://example.com/また、

curlツールを使用する場合は、PKCS #11 URI を指定することもできます。$ curl --key 'pkcs11:token=softhsm;id=%01;type=private?pin-value=111111' --cert 'pkcs11:token=softhsm;id=%01;type=cert' https://example.com/

関連情報

-

curl(1)、wget(1)、およびp11-kit(8)man ページ

5.4. Apache で秘密鍵を保護する HSM の使用

Apache HTTP サーバーは、ハードウェアセキュリティーモジュール (HSM) に保存されている秘密鍵と連携できます。これにより、鍵の漏えいや中間者攻撃を防ぐことができます。通常、これを行うには、ビジーなサーバーに高パフォーマンスの HSM が必要になります。

HTTPS プロトコルの形式でセキュアな通信を行うために、Apache HTTP サーバー (httpd) は OpenSSL ライブラリーを使用します。OpenSSL は、PKCS #11 にネイティブに対応しません。HSM を使用するには、エンジンインターフェイスを介して PKCS #11 モジュールへのアクセスを提供する openssl-pkcs11 パッケージをインストールする必要があります。通常のファイル名ではなく PKCS #11 の URI を使用すると、/etc/httpd/conf.d/ssl.conf 設定ファイルでサーバーの鍵と証明書を指定できます。以下に例を示します。

SSLCertificateFile "pkcs11:id=%01;token=softhsm;type=cert" SSLCertificateKeyFile "pkcs11:id=%01;token=softhsm;type=private?pin-value=111111"

httpd-manual パッケージをインストールして、TLS 設定を含む Apache HTTP サーバーの完全ドキュメントを取得します。/etc/httpd/conf.d/ssl.conf 設定ファイルで利用可能なディレクティブの詳細は、/usr/share/httpd/manual/mod/mod_ssl.html を参照してください。

5.5. Nginx で秘密鍵を保護する HSM の使用

Nginx HTTP サーバーは、ハードウェアセキュリティーモジュール (HSM) に保存されている秘密鍵と連携できます。これにより、鍵の漏えいや中間者攻撃を防ぐことができます。通常、これを行うには、ビジーなサーバーに高パフォーマンスの HSM が必要になります。

Nginx は暗号化操作に OpenSSL を使用するため、PKCS #11 への対応は openssl-pkcs11 エンジンを介して行う必要があります。Nginx は現在、HSM からの秘密鍵の読み込みのみに対応します。また、証明書は通常のファイルとして個別に提供する必要があります。/etc/nginx/nginx.conf 設定ファイルの server セクションで ssl_certificate オプションおよび ssl_certificate_key オプションを変更します。

ssl_certificate /path/to/cert.pem ssl_certificate_key "engine:pkcs11:pkcs11:token=softhsm;id=%01;type=private?pin-value=111111";

Nginx 設定ファイルの PKCS #11 URI に接頭辞 engine:pkcs11: が必要なことに注意してください。これは、他の pkcs11 接頭辞がエンジン名を参照するためです。

5.6. 関連情報

-

pkcs11.conf(5)の man ページ

第6章 polkit を使用したスマートカードへのアクセスの制御

PIN、PIN パッド、バイオメトリックなどのスマートカードに組み込まれたメカニズムでは防ぐことができない脅威に対処するため、およびより詳細な制御のために、RHEL は polkit フレームワークを使用してスマートカードへのアクセス制御を制御します。

システム管理者は、非特権ユーザーや非ローカルユーザー、サービスに対するスマートカードアクセスなど、特定のシナリオに合わせて polkit を設定できます。

6.1. polkit を介したスマートカードアクセス制御

PC/SC (Personal Computer/Smart Card) プロトコルは、スマートカードとそのリーダーをコンピューティングシステムに統合するための標準を指定します。RHEL では、pcsc-lite パッケージが、PC/SC の API を使用するスマートカードにアクセスするミドルウェアを提供します。このパッケージの一部である pcscd (PC/SC スマートカード) デーモンにより、システムが PC/SC プロトコルを使用してスマートカードにアクセスできるようになります。

PIN、PIN パッド、バイオメトリックなどのスマートカードに組み込まれたアクセス制御メカニズムは、考えられるすべての脅威をカバーするものではないため、RHEL は、より強力なアクセス制御に polkit フレームワークを使用します。polkit 認可マネージャーは、特権操作へのアクセスを許可できます。ディスクへのアクセスを許可することに加えて、polkit を使用して、スマートカードのセキュリティーを保護するポリシーを指定することもできます。たとえば、スマートカードで操作を実行できるユーザーを定義できます。

pcsc-lite パッケージをインストールし、pcscd デーモンを起動すると、システムは、/usr/share/polkit-1/actions/ ディレクトリーで定義されているポリシーを強制します。システム全体のデフォルトのポリシーは、/usr/share/polkit-1/actions/org.debian.pcsc-lite.policy ファイルにあります。Polkit ポリシーファイルは XML 形式を使用し、その構文は man ページの polkit(8) で説明されています。

polkitd は、/etc/polkit-1/rules.d/ ディレクトリーおよび /usr/share/polkit-1/rules.d/ ディレクトリーで、これらのディレクトリーに保存されているルールファイルの変更を監視します。ファイルには、JavaScript 形式の認可ルールが含まれています。システム管理者は、両方のディレクトリーにカスタムルールファイルを追加し、polkitd がファイル名に基づいてアルファベット順に読み込むことができます。2 つのファイルが同じ名前である場合は、最初に /etc/polkit-1/rules.d/ 内のファイルが読み込まれます。

関連情報

-

man ページの

polkit(8)、polkitd(8)、およびpcscd(8)

6.2. PC/SC および polkit に関連する問題のトラブルシューティング

pcsc-lite パッケージをインストールし、pcscd デーモンを起動した後に自動的に強制される Polkit ポリシーは、ユーザーがスマートカードと直接対話しない場合でも、ユーザーのセッションで認証を求められることがあります。GNOME では、以下のエラーメッセージが表示されます。

Authentication is required to access the PC/SC daemon

opensc などのスマートカードに関連する他のパッケージをインストールする場合は、システムが依存関係として pcsc-lite パッケージをインストールできることに注意してください。

スマートカードとの相互作用が必要なく、PC/SC デーモンの認可要求が表示されないようにする場合は、pcsc-lite パッケージを削除できます。必要なパッケージを最小限にとどめることが、セキュリティー上の推奨事項です。

スマートカードを使用する場合は、/usr/share/polkit-1/actions/org.debian.pcsc-lite.policy 時に、システムが提供するポリシーファイルのルールを確認して、トラブルシューティングを開始します。カスタムルールファイルは、/etc/polkit-1/rules.d/ ディレクトリーのポリシー (03-allow-pcscd.rules など) に追加できます。ルールファイルは JavaScript 構文を使用し、ポリシーファイルは XML 形式であることに注意してください。

システムに表示される認可要求を理解するには、以下の例のように Journal ログを確認します。

$ journalctl -b | grep pcsc

...

Process 3087 (user: 1001) is NOT authorized for action: access_pcsc

...

以前のログエントリーは、ユーザーがポリシーによるアクションを実行する権限を持っていないことを示しています。この拒否を解決するには、対応するルールを /etc/polkit-1/rules.d/ に追加します。

polkitd ユニットに関連するログエントリーも検索できます。以下に例を示します。

$ journalctl -u polkit

...

polkitd[NNN]: Error compiling script /etc/polkit-1/rules.d/00-debug-pcscd.rules

...

polkitd[NNN]: Operator of unix-session:c2 FAILED to authenticate to gain authorization for action org.debian.pcsc-lite.access_pcsc for unix-process:4800:14441 [/usr/libexec/gsd-smartcard] (owned by unix-user:group)

...

この出力では、最初のエントリーがルールファイルに構文エラーが含まれていることを示しています。2 番目のエントリーは、ユーザーが pcscd へのアクセスを取得できなかったことを示しています。

また、短いスクリプトを使用して、PC/SC プロトコルを使用するすべてのアプリケーションをリスト表示することもできます。pcsc-apps.sh などの実行ファイルを作成し、以下のコードを挿入します。

#!/bin/bash cd /proc for p in [0-9]* do if grep libpcsclite.so.1.0.0 $p/maps &> /dev/null then echo -n "process: " cat $p/cmdline echo " ($p)" fi done

root でスクリプトを実行します。

# ./pcsc-apps.sh

process: /usr/libexec/gsd-smartcard (3048)

enable-sync --auto-ssl-client-auth --enable-crashpad (4828)

...関連情報

-

man ページの

journalctl、polkit(8)、polkitd(8)、およびpcscd(8)

6.3. PC/SC への polkit 認可の詳細情報の表示

デフォルト設定では、polkit 認可フレームワークは、限られた情報のみをジャーナルログに送信します。新しいルールを追加することで、PC/SC プロトコル関連の polkit ログエントリーを拡張できます。

前提条件

-

システムに

pcsc-liteパッケージをインストールしている。 -

pcscdデーモンが実行中である。

手順

/etc/polkit-1/rules.d/ディレクトリーに新規ファイルを作成します。# touch /etc/polkit-1/rules.d/00-test.rules選択したエディターでファイルを編集します。以下に例を示します。

# vi /etc/polkit-1/rules.d/00-test.rules以下の行を挿入します。

polkit.addRule(function(action, subject) { if (action.id == "org.debian.pcsc-lite.access_pcsc" || action.id == "org.debian.pcsc-lite.access_card") { polkit.log("action=" + action); polkit.log("subject=" + subject); } });ファイルを保存して、エディターを終了します。

pcscdサービスおよびpolkitサービスを再起動します。# systemctl restart pcscd.service pcscd.socket polkit.service

検証

-

pcscdの認可リクエストを作成します。たとえば、Firefox の Web ブラウザーを開くか、openscが提供するpkcs11-tool -Lを使用します。 拡張ログエントリーを表示します。以下に例を示します。

# journalctl -u polkit --since "1 hour ago" polkitd[1224]: <no filename>:4: action=[Action id='org.debian.pcsc-lite.access_pcsc'] polkitd[1224]: <no filename>:5: subject=[Subject pid=2020481 user=user' groups=user,wheel,mock,wireshark seat=null session=null local=true active=true]

関連情報

-

man ページの

polkit(8)およびpolkitd(8)

6.4. 関連情報

- スマートカードへのアクセスの制御 Red Hat ブログの記事

第7章 設定コンプライアンスおよび脆弱性スキャンの開始

コンプライアンス監査は、指定したオブジェクトが、コンプライアンスポリシーに指定されているすべてのルールに従っているかどうかを判断するプロセスです。コンプライアンスポリシーは、コンピューティング環境で使用される必要な設定を指定するセキュリティー専門家が定義します。これは多くの場合は、チェックリストの形式を取ります。

コンプライアンスポリシーは組織により大幅に異なることがあり、同一組織内でもシステムが異なるとポリシーが異なる可能性があります。ポリシーは、各システムの目的や、組織におけるシステム重要性により異なります。カスタマイズしたソフトウェア設定や導入の特徴によっても、カスタマイズしたポリシーのチェックリストが必要になってきます。

7.1. RHEL における設定コンプライアンスツール

次の設定コンプライアンスツールを使用すると、Red Hat Enterprise Linux で完全に自動化されたコンプライアンス監査を実行できます。このツールは SCAP (Security Content Automation Protocol) 規格に基づいており、コンプライアンスポリシーの自動化に合わせるように設計されています。

- SCAP Workbench

-

scap-workbenchグラフィカルユーティリティーは、単一のローカルシステムまたはリモートシステム上で設定および脆弱性スキャンを実行するように設計されています。これらのスキャンと評価に基づくセキュリティーレポートの生成にも使用できます。 - OpenSCAP

OpenSCAPライブラリーは、付随するoscapコマンドラインユーティリティーとともに、ローカルシステムで設定スキャンと脆弱性スキャンを実行するように設計されています。これにより、設定コンプライアンスのコンテンツを検証し、スキャンおよび評価に基づいてレポートおよびガイドを生成します。重要OpenSCAP の使用中にメモリー消費の問題が発生する可能性があります。これにより、プログラムが途中で停止し、結果ファイルが生成されない可能性があります。詳細については、ナレッジベース記事 OpenSCAP のメモリー消費の問題 を参照してください。

- SCAP Security Guide (SSG)

-

scap-security-guideパッケージは、Linux システム用のセキュリティーポリシーのコレクションを提供します。このガイダンスは、セキュリティー強化に関する実践的なアドバイスのカタログで構成されています (該当する場合は、法規制要件へのリンクが含まれます)。このプロジェクトは、一般的なポリシー要件と特定の実装ガイドラインとの間にあるギャップを埋めることを目的としています。 - Script Check Engine (SCE)

-

SCAP プロトコルの拡張機能である SCE を使用すると、管理者は Bash、Python、Ruby などのスクリプト言語を使用してセキュリティーコンテンツを作成できます。SCE 拡張機能は、

openscap-engine-sceパッケージで提供されます。SCE 自体は SCAP 標準規格の一部ではありません。

複数のリモートシステムで自動コンプライアンス監査を実行する必要がある場合は、Red Hat Satellite 用の OpenSCAP ソリューションを利用できます。

関連情報

-

oscap(8)、scap-workbench(8)、およびscap-security-guide(8)の man ページ - Red Hat Security Demos: Creating Customized Security Policy Content to Automate Security Compliance

- Red Hat Security Demos: Defend Yourself with RHEL Security Technologies

- Red Hat Satellite の管理ガイドのセキュリティーコンプライアンスの管理

7.2. 脆弱性スキャン

7.2.1. Red Hat Security Advisories OVAL フィード

Red Hat Enterprise Linux のセキュリティー監査機能は、標準規格セキュリティー設定共通化手順 (Security Content Automation Protocol (SCAP)) を基にしています。SCAP は、自動化された設定、脆弱性およびパッチの確認、技術的な制御コンプライアンスアクティビティー、およびセキュリティーの測定に対応している多目的な仕様のフレームワークです。

SCAP 仕様は、スキャナーまたはポリシーエディターの実装が義務付けられていなくても、セキュリティーコンテンツの形式がよく知られて標準化されているエコシステムを作成します。これにより、組織は、採用しているセキュリティーベンダーの数に関係なく、セキュリティーポリシー (SCAP コンテンツ) を構築するのは一度で済みます。

セキュリティー検査言語 OVAL (Open Vulnerability Assessment Language) は、SCAP に不可欠で最も古いコンポーネントです。その他のツールやカスタマイズされたスクリプトとは異なり、OVAL は、宣言型でリソースが必要な状態を記述します。OVAL コードは、スキャナーと呼ばれる OVAL インタープリターツールを使用して直接実行されることは決してありません。OVAL が宣言型であるため、評価されるシステムの状態が偶然修正されることはありません。

他のすべての SCAP コンポーネントと同様に、OVAL は XML に基づいています。SCAP 標準規格は、いくつかのドキュメント形式を定義します。この形式にはそれぞれ異なる種類の情報が記載され、異なる目的に使用されます。

Red Hat 製品セキュリティー を使用すると、Red Hat 製品をお使いのお客様に影響を及ぼすセキュリティー問題をすべて追跡して調査します。Red Hat カスタマーポータルで簡潔なパッチやセキュリティーアドバイザリーを適時提供します。Red Hat は OVAL パッチ定義を作成してサポートし、マシンが判読可能なセキュリティーアドバイザリーを提供します。

プラットフォーム、バージョン、およびその他の要因が異なるため、Red Hat 製品セキュリティーによる脆弱性の重大度定性評価は、サードパーティーが提供する Common Vulnerability Scoring System (CHC) のベースライン評価と完全に一致しているわけではありません。したがって、サードパーティーが提供する定義ではなく、RHSA OVAL 定義を使用することが推奨されます。

各 RHSA OVAL 定義 は完全なパッケージとして利用でき、新しいセキュリティーアドバイザリーが Red Hat カスタマーポータルで利用可能になってから 1 時間以内に更新されます。

各 OVAL パッチ定義は、Red Hat セキュリティーアドバイザリー (RHSA) と 1 対 1 にマッピングしています。RHSA には複数の脆弱性に対する修正が含まれるため、各脆弱性は、共通脆弱性識別子 (Common Vulnerabilities and Exposures (CVE)) 名ごとに表示され、公開バグデータベースの該当箇所へのリンクが示されます。

RHSA OVAL 定義は、システムにインストールされている RPM パッケージで脆弱なバージョンを確認するように設計されています。この定義は拡張でき、パッケージが脆弱な設定で使用されているかどうかを見つけるなど、さらに確認できるようにすることができます。この定義は、Red Hat が提供するソフトウェアおよび更新に対応するように設計されています。サードパーティーソフトウェアのパッチ状態を検出するには、追加の定義が必要です。

Red Hat Insights for Red Hat Enterprise Linux コンプライアンスサービス は、IT セキュリティーおよびコンプライアンス管理者が Red Hat Enterprise Linux システムのセキュリティーポリシーのコンプライアンスを評価、監視、およびレポートするのに役立ちます。また、コンプライアンスサービス UI 内で完全に SCAP セキュリティーポリシーを作成および管理することもできます。

7.2.2. システムの脆弱性のスキャン

oscap コマンドラインユーティリティーを使用すると、ローカルシステムのスキャン、設定コンプライアンスコンテンツの確認、ならびにスキャンおよび評価を基にしたレポートとガイドの生成が可能です。このユーティリティーは、OpenSCAP ライブラリーのフロントエンドとしてサービスを提供し、その機能を処理する SCAP コンテンツのタイプに基づいてモジュール (サブコマンド) にグループ化します。

前提条件

-

openscap-scannerおよびbzip2パッケージがインストールされます。

手順

システムに最新 RHSA OVAL 定義をダウンロードします。

# wget -O - https://www.redhat.com/security/data/oval/v2/RHEL8/rhel-8.oval.xml.bz2 | bzip2 --decompress > rhel-8.oval.xmlシステムの脆弱性をスキャンし、vulnerability.html ファイルに結果を保存します。

# oscap oval eval --report vulnerability.html rhel-8.oval.xml

検証

結果をブラウザーで確認します。以下に例を示します。

$ firefox vulnerability.html &

関連情報

-

oscap(8)の man ページ - Red Hat OVAL 定義

- OpenSCAP のメモリー消費の問題

7.2.3. リモートシステムの脆弱性のスキャン

SSH プロトコルで oscap-ssh ツールを使用して、OpenSCAP スキャナーでリモートシステムの脆弱性を確認することもできます。

前提条件

-

openscap-utilsおよびbzip2パッケージは、スキャンに使用するシステムにインストールされます。 -

リモートシステムに

openscap-scannerパッケージがインストールされている。 - リモートシステムで SSH サーバーが実行している。

手順

システムに最新 RHSA OVAL 定義をダウンロードします。

# wget -O - https://www.redhat.com/security/data/oval/v2/RHEL8/rhel-8.oval.xml.bz2 | bzip2 --decompress > rhel-8.oval.xml脆弱性に対して、ホスト名 machine1、ポート 22 で実行する SSH、およびユーザー名 joesec でリモートシステムをスキャンし、結果を remote-vulnerability.html ファイルに保存します。

# oscap-ssh joesec@machine1 22 oval eval --report remote-vulnerability.html rhel-8.oval.xml

関連情報

-

oscap-ssh(8) - Red Hat OVAL 定義

- OpenSCAP のメモリー消費の問題

7.3. 設定コンプライアンススキャン

7.3.1. RHEL の設定コンプライアンス

設定コンプライアンススキャンを使用して、特定の組織で定義されているベースラインに準拠できます。たとえば、米国政府と協力している場合は、システムを Operating System Protection Profile (OSPP) に準拠させ、支払い処理業者の場合は、システムを Payment Card Industry Data Security Standard (PCI-DSS) に準拠させなければならない場合があります。設定コンプライアンススキャンを実行して、システムセキュリティーを強化することもできます。

Red Hat は、対象コンポーネント向けの Red Hat のベストプラクティスに従っているため、SCAP Security Guide パッケージで提供される Security Content Automation Protocol (SCAP) コンテンツに従うことを推奨します。

SCAP Security Guide パッケージは、SCAP 1.2 および SCAP 1.3 標準規格に準拠するコンテンツを提供します。openscap scanner ユーティリティーは、SCAP Security Guide パッケージで提供される SCAP 1.2 および SCAP 1.3 コンテンツの両方と互換性があります。

設定コンプライアンススキャンを実行しても、システムが準拠しているとは限りません。

SCAP セキュリティーガイドスイートは、データストリームのドキュメント形式で、複数のプラットフォームのプロファイルを提供します。データストリームは、定義、ベンチマーク、プロファイル、および個々のルールが含まれるファイルです。各ルールでは、コンプライアンスの適用性と要件を指定します。RHEL は、セキュリティーポリシーを扱う複数のプロファイルを提供します。Red Hat データストリームには、業界標準の他に、失敗したルールの修正に関する情報も含まれます。

コンプライアンススキャンリソースの構造

Data stream ├── xccdf | ├── benchmark | ├── profile | | ├──rule reference | | └──variable | ├── rule | ├── human readable data | ├── oval reference ├── oval ├── ocil reference ├── ocil ├── cpe reference └── cpe └── remediation

プロファイルは、OSPP、PCI-DSS、Health Insurance Portability and Accountability Act (HIPAA) などのセキュリティーポリシーに基づく一連のルールです。これにより、セキュリティー標準規格に準拠するために、システムを自動で監査できます。

プロファイルを変更 (調整) して、パスワードの長さなどの特定のルールをカスタマイズできます。プロファイルの調整の詳細は、SCAP Workbench を使用したセキュリティープロファイルのカスタマイズ を参照してください。

7.3.2. OpenSCAP スキャン結果の例

OpenSCAP スキャンに適用されるデータストリームとプロファイル、およびシステムのさまざまなプロパティーに応じて、各ルールから特定の結果が生成される場合があります。以下に考えられる結果とその意味の簡単な説明を示します。

- Pass

- スキャンでは、このルールとの競合が見つかりませんでした。

- Fail

- スキャンで、このルールとの競合が検出されました。

- Not checked

- OpenSCAP はこのルールの自動評価を実行しません。システムがこのルールに手動で準拠しているかどうかを確認してください。

- Not applicable

- このルールは、現在の設定には適用されません。

- Not selected

- このルールはプロファイルには含まれません。OpenSCAP はこのルールを評価せず、結果にこのようなルールは表示されません。

- Error

-

スキャンでエラーが発生しました。詳細は、

--verbose DEVELオプションを指定してoscapコマンドで確認できます。バグレポート を作成することを検討してください。 - Unknown

-

スキャンで予期しない状況が発生しました。詳細は、

`--verbose DEVELオプションを指定してoscapコマンドを入力できます。バグレポート を作成することを検討してください。

7.3.3. 設定コンプライアンスのプロファイルの表示

スキャンまたは修復にプロファイルを使用することを決定する前に、oscap info サブコマンドを使用して、プロファイルを一覧表示し、詳細な説明を確認できます。

前提条件

-

openscap-scannerパッケージおよびscap-security-guideパッケージがインストールされている。

手順

SCAP Security Guide プロジェクトが提供するセキュリティーコンプライアンスプロファイルで利用可能なファイルをすべて表示します。

$ ls /usr/share/xml/scap/ssg/content/ ssg-firefox-cpe-dictionary.xml ssg-rhel6-ocil.xml ssg-firefox-cpe-oval.xml ssg-rhel6-oval.xml ... ssg-rhel6-ds-1.2.xml ssg-rhel8-oval.xml ssg-rhel8-ds.xml ssg-rhel8-xccdf.xml ...oscap infoサブコマンドを使用して、選択したデータストリームに関する詳細情報を表示します。データストリームを含む XML ファイルは、名前に-ds文字列で示されます。Profilesセクションでは、利用可能なプロファイルと、その ID のリストを確認できます。$ oscap info /usr/share/xml/scap/ssg/content/ssg-rhel8-ds.xml Profiles: ... Title: Health Insurance Portability and Accountability Act (HIPAA) Id: xccdf_org.ssgproject.content_profile_hipaa Title: PCI-DSS v3.2.1 Control Baseline for Red Hat Enterprise Linux 8 Id: xccdf_org.ssgproject.content_profile_pci-dss Title: OSPP - Protection Profile for General Purpose Operating Systems Id: xccdf_org.ssgproject.content_profile_ospp ...データストリームファイルからプロファイルを選択し、選択したプロファイルに関する追加情報を表示します。そのためには、

oscap infoに--profileオプションを指定した後に、直前のコマンドの出力で表示された ID の最後のセクションを指定します。たとえば、HIPPA プロファイルの ID はxccdf_org.ssgproject.content_profile_hipaaで、--profileオプションの値はhipaaです。$ oscap info --profile hipaa /usr/share/xml/scap/ssg/content/ssg-rhel8-ds.xml ... Profile Title: Health Insurance Portability and Accountability Act (HIPAA) Description: The HIPAA Security Rule establishes U.S. national standards to protect individuals’ electronic personal health information that is created, received, used, or maintained by a covered entity. ...

関連情報

-

scap-security-guide (8)の man ページ - OpenSCAP のメモリー消費の問題

7.3.4. 特定のベースラインによる設定コンプライアンスの評価

システムが特定のベースラインに準拠しているかどうかを確認するには、次の手順に従います。

前提条件

-

openscap-scannerパッケージおよびscap-security-guideパッケージがインストールされている。 - システムが準拠する必要があるベースライン内のプロファイルの ID を知っている必要があります。ID を見つけるには、設定コンプライアンスのプロファイルの表示 を参照してください。

手順

選択したプロファイルでそのシステムがどのように複雑であるかを評価し、スキャン内容を保存すると、以下のように HTML ファイル (report.html) に結果が表示されます。

$ oscap xccdf eval --report report.html --profile hipaa /usr/share/xml/scap/ssg/content/ssg-rhel8-ds.xml必要に応じて、コンプライアンスに対して、ホスト名

machine1、ポート22で実行する SSH、およびユーザー名joesecでリモートシステムをスキャンし、結果をremote-vulnerability.htmlファイルに保存します。$ oscap-ssh joesec@machine1 22 xccdf eval --report remote_report.html --profile hipaa /usr/share/xml/scap/ssg/content/ssg-rhel8-ds.xml

関連情報

-

scap-security-guide (8)の man ページ -

/usr/share/doc/scap-security-guide/ディレクトリーにあるSCAP Security Guideドキュメント -

/usr/share/doc/scap-security-guide/guides/ssg-rhel8-guide-index.html-scap-security-guide-docパッケージでインストールされた Red Hat Enterprise Linux 8 のセキュアな設定ガイド - OpenSCAP のメモリー消費の問題

7.4. 特定のベースラインに合わせたシステムの修復

特定のベースラインに合わせて RHEL システムを修正できます。この例では Health Insurance Portability and Accountability Act (HIPAA) プロファイルを使用していますが、SCAP Security Guide で提供されている他のプロファイルに合わせて修正することもできます。使用可能なプロファイルのリストの詳細は、設定コンプライアンスのプロファイルの表示 を参照してください。

修正 オプションが有効な状態でのシステム評価は、慎重に行わないとシステムが機能不全に陥る場合があります。Red Hat は、セキュリティーを強化した修正で加えられた変更を元に戻す自動手段は提供していません。修復は、デフォルト設定の RHEL システムで対応しています。インストール後にシステムが変更した場合は、修正を実行しても、必要なセキュリティープロファイルに準拠しない場合があります。

前提条件

-

RHEL システムに、

scap-security-guideパッケージがインストールされている。

手順

oscapコマンドに--remediateオプションを指定して使用します。# oscap xccdf eval --profile hipaa --remediate /usr/share/xml/scap/ssg/content/ssg-rhel8-ds.xml- システムを再起動します。

検証

システムの OSPP プロファイルへのコンプライアンスを評価し、スキャン結果を

ospp_report.htmlファイルに保存します。$ oscap xccdf eval --report hipaa_report.html --profile hipaa /usr/share/xml/scap/ssg/content/ssg-rhel8-ds.xml

関連情報

-

scap-security-guide(8)およびoscap(8)の man ページ - ナレッジベースの記事 Complementing the DISA benchmark using the SSG content

7.5. SSG Ansible Playbook を使用して、特定のベースラインに合わせてシステムを修正する

SCAP Security Guide プロジェクトの Ansible Playbook ファイルを使用して、特定のベースラインに合わせてシステムを修正できます。この例では Health Insurance Portability and Accountability Act (HIPAA) プロファイルを使用していますが、SCAP Security Guide で提供されている他のプロファイルに合わせて修正することもできます。使用可能なプロファイルのリストの詳細は、設定コンプライアンスのプロファイルの表示 を参照してください。

修正 オプションが有効な状態でのシステム評価は、慎重に行わないとシステムが機能不全に陥る場合があります。Red Hat は、セキュリティーを強化した修正で加えられた変更を元に戻す自動手段は提供していません。修復は、デフォルト設定の RHEL システムで対応しています。インストール後にシステムが変更した場合は、修正を実行しても、必要なセキュリティープロファイルに準拠しない場合があります。

前提条件

-

scap-security-guideパッケージがインストールされている。 -

ansible-coreパッケージがインストールされている。詳細は、Ansible インストールガイド を参照してください。

RHEL 8.6 以降では、Ansible Engine は、ビルトインモジュールのみを含む ansible-core パッケージに置き換えられました。Ansible 修復の多くは、community コレクションおよび Portable Operating System Interface (POSIX) コレクションのモジュールを使用することに注意してください。これは組み込みモジュールには含まれていません。この場合は、Ansible 修復の代わりに Bash 修復を使用できます。RHEL 8 の Red Hat Connector には、Ansible Core で修復 Playbook を機能させるために必要な Ansible モジュールが含まれています。

手順

Ansible を使用して OSPP に合わせてシステムを修正します。

# ansible-playbook -i localhost, -c local /usr/share/scap-security-guide/ansible/rhel8-playbook-hipaa.yml- システムを再起動します。

検証

システムの OSPP プロファイルへのコンプライアンスを評価し、スキャン結果を

ospp_report.htmlファイルに保存します。# oscap xccdf eval --profile hipaa --report hipaa_report.html /usr/share/xml/scap/ssg/content/ssg-rhel8-ds.xml

関連情報

-

scap-security-guide(8)およびoscap(8)の man ページ - Ansible ドキュメント

7.6. システムを特定のベースラインに合わせるための修復用 Ansible Playbook の作成

以下の手順に従って、必要な修復のみを含む Ansible Playbook を作成し、システムを特定のベースラインに合わせます。この例では、Health Insurance Portability and Accountability Act (HIPAA) プロファイルを使用します。この手順では、要件を満たしていない小規模の Playbook を作成します。以下の手順に従うと、システムを変更せずに、後のアプリケーション用にファイルの準備を行うだけです。

RHEL 8.6 では、Ansible Engine は、組み込みモジュールのみを含む ansible-core パッケージに置き換えられました。Ansible 修復の多くは、community コレクションおよび Portable Operating System Interface (POSIX) コレクションのモジュールを使用することに注意してください。これは組み込みモジュールには含まれていません。この場合は、Bash 修復を Ansible 修復の代わりに使用できます。RHEL 8.6 の Red Hat Connector には、Ansible Core で修復 Playbook を機能させるために必要な Ansible モジュールが含まれています。

前提条件

-

scap-security-guideパッケージがインストールされている。

手順

システムをスキャンして結果を保存します。

# oscap xccdf eval --profile hipaa --results <hipaa-results.xml> /usr/share/xml/scap/ssg/content/ssg-rhel8-ds.xml結果が含まれるファイルで、結果 ID の値を見つけます。

# oscap info <hipaa-results.xml>手順 1 で生成されたファイルに基づいて Ansible Playbook を生成します。

# oscap xccdf generate fix --fix-type ansible --result-id <xccdf_org.open-scap_testresult_xccdf_org.ssgproject.content_profile_hipaa> --output <hipaa-remediations.yml> <hipaa-results.xml>-

生成されたファイルを確認します。これには、手順 1 で実行されたスキャン中に失敗したルールの Ansible 修復が含まれています。この生成されたファイルを確認した後、

ansible-playbook <hipaa-remediations.yml>コマンドを使用して適用できます。

検証

-

お使いのテキストエディターで、手順 1 で実行したスキャンで失敗したルールが、生成した

<hipaa-remediations.yml>ファイルに含まれていることを確認します。

関連情報

-

scap-security-guide(8)およびoscap(8)の man ページ - Ansible ドキュメント

7.7. 後でアプリケーションを修復するための Bash スクリプトの作成

この手順を使用して、システムを HIPAA などのセキュリティープロファイルと調整する修正を含む Bash スクリプトを作成します。次の手順では、システムに変更を加えることなく、後のアプリケーション用にファイルを準備する方法を説明します。

前提条件

-

RHEL システムに、

scap-security-guideパッケージがインストールされている。

手順

oscapコマンドを使用してシステムをスキャンし、結果を XML ファイルに保存します。以下の例では、oscapはhipaaプロファイルに対してシステムを評価します。# oscap xccdf eval --profile hipaa --results <hipaa-results.xml> /usr/share/xml/scap/ssg/content/ssg-rhel8-ds.xml結果が含まれるファイルで、結果 ID の値を見つけます。

# oscap info <hipaa-results.xml>手順 1 で生成された結果ファイルに基づいて Bash スクリプトを生成します。

# oscap xccdf generate fix --fix-type bash --result-id <xccdf_org.open-scap_testresult_xccdf_org.ssgproject.content_profile_hipaa> --output <hipaa-remediations.sh> <hipaa-results.xml>-

<hipaa-remediations.sh>ファイルには、手順 1 で実行されたスキャン中に失敗したルールの修復が含まれます。この生成されたファイルを確認したら、このファイルと同じディレクトリー内で、./<hipaa-remediations.sh>コマンドを使用してファイルを適用できます。

検証

-

お使いのテキストエディターで、手順 1 で実行したスキャンで失敗したルールが

<hipaa-remediations.sh>ファイルに含まれていることを確認します。

関連情報

-

scap-security-guide(8)、oscap(8)、およびbash(1)の man ページ

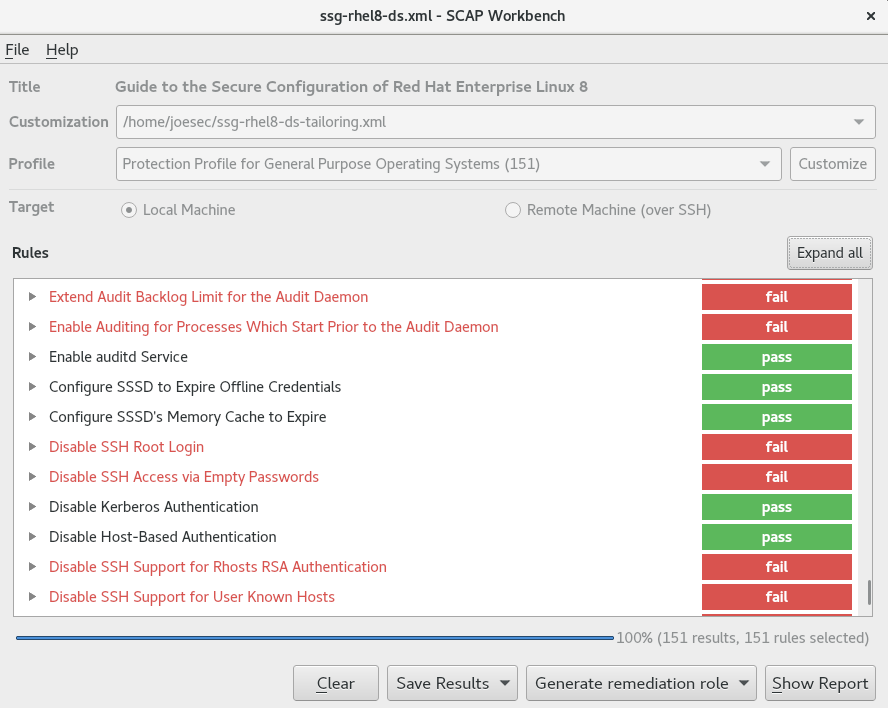

7.8. SCAP Workbench を使用したカスタムプロファイルでシステムのスキャン

SCAP Workbench (scap-workbench) パッケージはグラフィカルユーティリティーで、1 台のローカルシステムまたはリモートシステムで設定スキャンと脆弱性スキャンを実行し、システムの修復を実行して、スキャン評価に基づくレポートを生成します。oscap コマンドラインユーティリティーとの比較は、SCAP Workbench には限定的な機能しかないことに注意してください。SCAP Workbench は、データストリームファイルの形式でセキュリティーコンテンツを処理します。

7.8.1. SCAP Workbench を使用したシステムのスキャンおよび修復

選択したセキュリティーポリシーに対してシステムを評価するには、以下の手順に従います。

前提条件

-

scap-workbenchパッケージがシステムにインストールされている。

手順

GNOME Classicデスクトップ環境からSCAP Workbenchを実行するには、Super キーを押してアクティビティーの概要を開き、scap-workbenchと入力して Enterを押します。または、次のコマンドを実行します。$ scap-workbench &以下のオプションのいずれかを使用してセキュリティーポリシーを選択します。

-

開始ウィンドウの

Load Contentボタン -

Open content from SCAP Security Guide FileメニューのOpen Other Contentで、XCCDF、SCAP RPM、またはデータストリームファイルの各ファイルを検索します。

-

開始ウィンドウの

Remediate チェックボックスを選択して、システム設定の自動修正を行うことができます。このオプションを有効にすると、

SCAP Workbenchは、ポリシーにより適用されるセキュリティールールに従ってシステム設定の変更を試みます。このプロセスは、システムスキャン時に失敗した関連チェックを修正する必要があります。警告修正オプションが有効な状態でのシステム評価は、慎重に行わないとシステムが機能不全に陥る場合があります。Red Hat は、セキュリティーを強化した修正で加えられた変更を元に戻す自動手段は提供していません。修復は、デフォルト設定の RHEL システムで対応しています。インストール後にシステムが変更した場合は、修正を実行しても、必要なセキュリティープロファイルに準拠しない場合があります。Scan ボタンをクリックし、選択したプロファイルでシステムをスキャンします。

-

スキャン結果を XCCDF ファイル、ARF ファイル、または HTML ファイルの形式で保存するには、Save Results コンボボックスをクリックします。

HTML Reportオプションを選択して、スキャンレポートを、人間が判読できる形式で生成します。XCCDF 形式および ARF (データストリーム) 形式は、追加の自動処理に適しています。3 つのオプションはすべて繰り返し選択できます。 - 結果ベースの修復をファイルにエクスポートするには、ポップアップメニューの Generate remediation role を使用します。

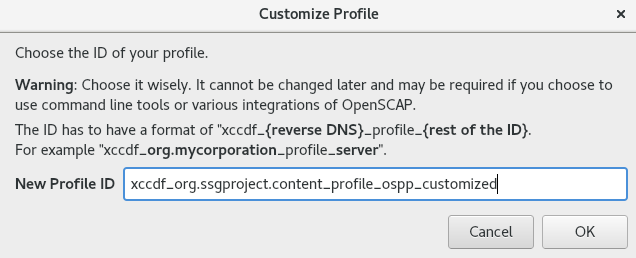

7.8.2. SCAP Workbench を使用したセキュリティープロファイルのカスタマイズ

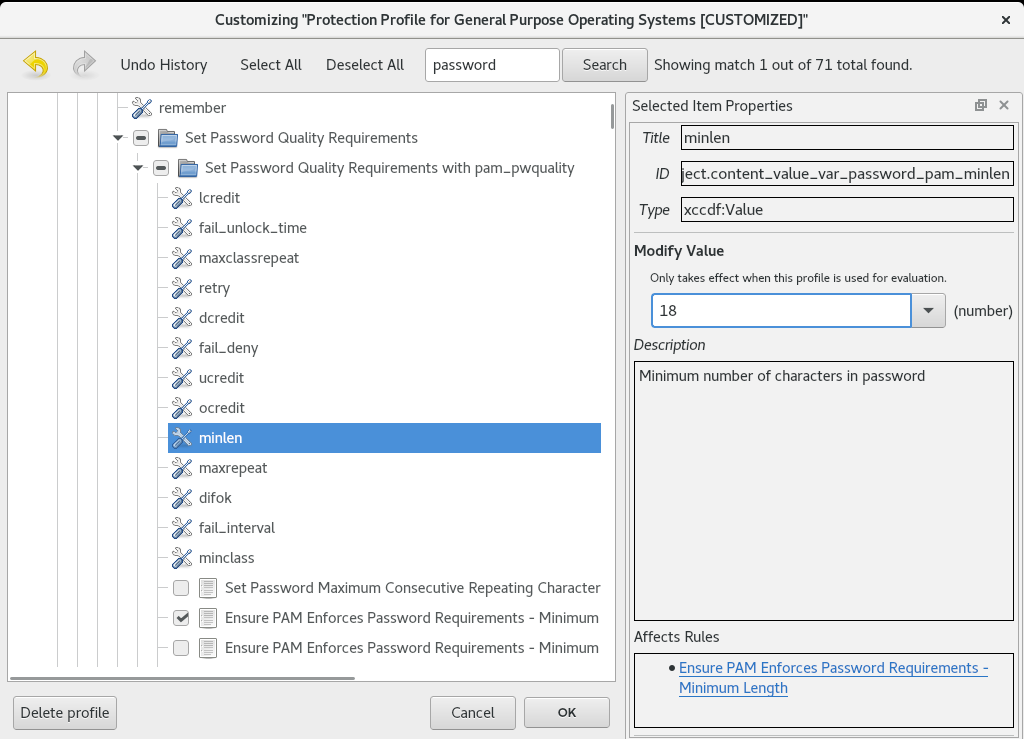

セキュリティープロファイルをカスタマイズするには、特定のルール (パスワードの最小長など) のパラメーターを変更し、別の方法で対象とするルールを削除し、追加のルールを選択して内部ポリシーを実装できます。プロファイルをカスタマイズして新しいルールの定義はできません。

以下の手順では、SCAP Workbench を使用してプロファイルをカスタマイズ (調整) します。oscap コマンドラインユーティリティーで使用するようにカスタマイズしたプロファイルを保存することもできます。

前提条件

-

scap-workbenchパッケージがシステムにインストールされている。

手順

-

SCAP Workbenchを実行し、Open content from SCAP Security GuideまたはFileメニューのOpen Other Contentを使用してカスタマイズするプロファイルを選択します。 選択したセキュリティープロファイルを必要に応じて調整するには、Customize ボタンをクリックします。

これにより、元のデータストリームファイルを変更せずに現在選択されているプロファイルを変更できる新しいカスタマイズウィンドウが開きます。新しいプロファイル ID を選択します。

- 論理グループに分けられたルールを持つツリー構造を使用するか、Search フィールドを使用して変更するルールを検索します。

ツリー構造のチェックボックスを使用した include ルールまたは exclude ルール、または必要に応じてルールの値を変更します。

- OK ボタンをクリックして変更を確認します。

変更内容を永続的に保存するには、以下のいずれかのオプションを使用します。

-

FileメニューのSave Customization Onlyを使用して、カスタマイズファイルを別途保存します。 FileメニューSave Allを選択して、すべてのセキュリティーコンテンツを一度に保存します。Into a directoryオプションを選択すると、SCAP Workbenchは、データストリームファイルおよびカスタマイズファイルの両方を、指定した場所に保存します。これはバックアップソリューションとして使用できます。As RPMオプションを選択すると、SCAP Workbenchに、データストリームファイル、ならびにカスタマイズファイルを含む RPM パッケージの作成を指示できます。これは、リモートでスキャンできないシステムにセキュリティーコンテンツを配布したり、詳細な処理のためにコンテンツを配信するのに便利です。

-

SCAP Workbench は、カスタマイズしたプロファイル向けの結果ベースの修正に対応していないため、oscap コマンドラインユーティリティーでエクスポートした修正を使用します。

7.8.3. 関連情報

-

scap-workbench (8)の man ページ -

scap-workbenchパッケージで提供される/usr/share/doc/scap-workbench/user_manual.htmlファイル - カスタマイズされた SCAP ポリシーを Satellite 6.x KCS でデプロイする 記事

7.9. インストール直後にセキュリティープロファイルに準拠するシステムのデプロイメント

OpenSCAP スイートを使用して、インストールプロセスの直後に、OSPP や PCI-DSS、HIPAA プロファイルなどのセキュリティープロファイルに準拠する RHEL システムをデプロイできます。このデプロイメント方法を使用すると、修正スクリプトを使用して後で適用できない特定のルール (パスワードの強度とパーティション化のルールなど) を適用できます。

7.9.1. GUI を備えたサーバーと互換性のないプロファイル

SCAP セキュリティーガイド の一部として提供される一部のセキュリティープロファイルは、Server with GUI ベースの環境の拡張パッケージセットと互換性がない場合があります。したがって、次のプロファイルのいずれかに準拠するシステムをインストールする場合は、Server with GUIを選択しないでください。

表7.1 GUI を備えたサーバーと互換性のないプロファイル

| プロファイル名 | プロファイル ID | 理由 | 備考 |

|---|---|---|---|

| CIS Red Hat Enterprise Linux 8 Benchmark for Level 2 - Server |

|

パッケージ | |

| CIS Red Hat Enterprise Linux 8 Benchmark for Level 1 - Server |

|

パッケージ | |

| Unclassified Information in Non-federal Information Systems and Organizations (NIST 800-171) |

|

| |

| Protection Profile for General Purpose Operating Systems |

|

| |

| DISA STIG for Red Hat Enterprise Linux 8 |

|

パッケージ | RHEL バージョン 8.4 以降で、RHEL システムを DISA STIG に準拠した Server with GUI としてインストールするには、DISA STIG with GUI プロファイルを使用できます。 |

7.9.2. グラフィカルインストールを使用したベースライン準拠の RHEL システムのデプロイメント

この手順を使用して、特定のベースラインに合わせた RHEL システムをデプロイします。この例では、OSPP (Protection Profile for General Purpose Operating System) を使用します。

SCAP セキュリティーガイド の一部として提供される一部のセキュリティープロファイルは、Server with GUI ベースの環境の拡張パッケージセットと互換性がない場合があります。詳細は、GUI サーバーと互換性のないプロファイル を参照してください。

前提条件

-

グラフィカルインストールプログラムでシステムを起動している。OSCAP Anaconda アドオン はインタラクティブなテキストのみのインストールをサポートしていないことに注意してください。 -

インストール概要画面を開いている。

手順

-

インストール概要画面で、ソフトウェアの選択をクリックします。ソフトウェアの選択画面が開きます。 -

ベース環境ペインで、サーバー環境を選択します。ベース環境は、1 つだけ選択できます。 -

完了をクリックして設定を適用し、インストール概要画面に戻ります。 -

OSPP には、準拠する必要がある厳密なパーティション分割要件があるため、

/boot、/home、/var、/tmp、/var/log、/var/tmp、および/var/log/auditにそれぞれパーティションを作成します。 -

セキュリティーポリシーをクリックします。セキュリティーポリシー画面が開きます。 -

システムでセキュリティーポリシーを有効にするには、

セキュリティーポリシーの適用をONに切り替えます。 -

プロファイルペインで

Protection Profile for General Purpose Operating Systemsプロファイルを選択します。 -

プロファイルの選択をクリックして選択を確定します。 -

画面下部に表示される

Protection Profile for General Purpose Operating Systemsの変更を確定します。残りの手動変更を完了します。 グラフィカルインストールプロセスを完了します。

注記グラフィカルインストールプログラムは、インストールに成功すると、対応するキックスタートファイルを自動的に作成します。

/root/anaconda-ks.cfgファイルを使用して、OSPP 準拠のシステムを自動的にインストールできます。

検証

インストール完了後にシステムの現在のステータスを確認するには、システムを再起動して新しいスキャンを開始します。

# oscap xccdf eval --profile ospp --report eval_postinstall_report.html /usr/share/xml/scap/ssg/content/ssg-rhel8-ds.xml

関連情報

7.9.3. キックスタートを使用したベースライン準拠の RHEL システムのデプロイメント

この手順を使用して、特定のベースラインに合わせた RHEL システムをデプロイします。この例では、OSPP (Protection Profile for General Purpose Operating System) を使用します。

前提条件

-

RHEL 8 システムに、

scap-security-guideパッケージがインストールされている。

手順

-

キックスタートファイル

/usr/share/scap-security-guide/kickstart/ssg-rhel8-ospp-ks.cfgを、選択したエディターで開きます。 -

設定要件を満たすように、パーティション設定スキームを更新します。OSPP に準拠するには、

/boot、/home、/var、/tmp、/var/log、/var/tmp、および/var/log/auditの個別のパーティションを保持する必要があります。パーティションのサイズのみ変更することができます。 - キックスタートインストールを開始する方法は、キックスタートインストールの開始を参照してください。

キックスタートファイルのパスワードでは、OSPP の要件が確認されていません。

検証

インストール完了後にシステムの現在のステータスを確認するには、システムを再起動して新しいスキャンを開始します。

# oscap xccdf eval --profile ospp --report eval_postinstall_report.html /usr/share/xml/scap/ssg/content/ssg-rhel8-ds.xml

7.10. コンテナーおよびコンテナーイメージの脆弱性スキャン

以下の手順を使用して、コンテナーまたはコンテナーイメージのセキュリティー脆弱性を検索します。

oscap-podman コマンドは、RHEL 8.2 で利用できます。RHEL 8.1 および 8.0 の場合は、ナレッジベースの記事 Using OpenSCAP for scanning containers in RHEL 8 で説明されている回避策を利用します。

前提条件

-

openscap-utilsおよびbzip2パッケージがインストールされます。

手順

システムに最新 RHSA OVAL 定義をダウンロードします。

# wget -O - https://www.redhat.com/security/data/oval/v2/RHEL8/rhel-8.oval.xml.bz2 | bzip2 --decompress > rhel-8.oval.xmlコンテナーまたはコンテナーイメージの ID を取得します。以下に例を示します。

# podman images REPOSITORY TAG IMAGE ID CREATED SIZE registry.access.redhat.com/ubi8/ubi latest 096cae65a207 7 weeks ago 239 MBコンテナーまたはコンテナーイメージで脆弱性をスキャンし、結果を vulnerability.html ファイルに保存します。

# oscap-podman 096cae65a207 oval eval --report vulnerability.html rhel-8.oval.xmloscap-podmanコマンドには root 権限が必要で、コンテナーの ID は最初の引数であることに注意してください。

検証

結果をブラウザーで確認します。以下に例を示します。

$ firefox vulnerability.html &

関連情報

-

詳細は、

oscap-podman(8)およびoscap(8)の man ページを参照してください。

7.11. 特定のベースラインを使用したコンテナーまたはコンテナーイメージのセキュリティーコンプライアンスの評価

以下の手順に従い、OSPP (Operating System Protection Profile) や PCI-DSS (Payment Card Industry Data Security Standard)、Health Insurance Portability and Accountability Act (HIPAA) などの特定のセキュリティーベースラインのあるコンテナーまたはコンテナーイメージのコンプライアンスを評価します。

oscap-podman コマンドは、RHEL 8.2 で利用できます。RHEL 8.1 および 8.0 の場合は、ナレッジベースの記事 Using OpenSCAP for scanning containers in RHEL 8 で説明されている回避策を利用します。

前提条件

-

openscap-utilsパッケージおよびscap-security-guideパッケージがインストールされている。

手順

コンテナーまたはコンテナーイメージの ID を取得します。以下に例を示します。

# podman images REPOSITORY TAG IMAGE ID CREATED SIZE registry.access.redhat.com/ubi8/ubi latest 096cae65a207 7 weeks ago 239 MBHIPAA プロファイルでコンテナーイメージのコンプライアンスを評価し、スキャン結果を report.html ファイルに保存します。

# oscap-podman 096cae65a207 xccdf eval --report report.html --profile hipaa /usr/share/xml/scap/ssg/content/ssg-rhel8-ds.xmlOSPP または PCI-DSS ベースラインでセキュリティーコンプライアンスを評価する場合は、096cae65a207 をコンテナーイメージの ID に、hipaa の値を ospp または pci-dss に置き換えます。

oscap-podmanコマンドには、root 権限が必要なことに注意してください。

検証

結果をブラウザーで確認します。以下に例を示します。

$ firefox report.html &

notapplicable が付いているルールは、コンテナー化されたシステムには適用されないルールです。これらのルールは、ベアメタルおよび仮想化システムにのみ適用されます。

関連情報

-

oscap-podman(8)およびscap-security-guide(8)の man ページ。 -

/usr/share/doc/scap-security-guide/ディレクトリー。

7.12. RHEL 8 で対応している SCAP セキュリティーガイドプロファイル

RHEL の特定のマイナーリリースで提供される SCAP コンテンツのみを使用します。これは、ハードニングに参加するコンポーネントが新機能で更新されるためです。SCAP コンテンツは、この更新を反映するように変更されますが、常に後方互換性があるわけではありません。

以下の表は、RHEL の各マイナーバージョンで提供されるプロファイルと、プロファイルが適合するポリシーのバージョンを検出できます。

表7.2 RHEL 8.9 でサポートされる SCAP セキュリティーガイドプロファイル

| プロファイル名 | プロファイル ID | ポリシーバージョン |

|---|---|---|

| Security of Information Systems (ANSSI) BP-028 Enhanced Level |

| 2.0 |

| French National Agency for the Security of Information Systems (ANSSI) BP-028 High Level |

| 2.0 |

| French National Agency for the Security of Information Systems (ANSSI) BP-028 Intermediary Level |

| 2.0 |

| French National Agency for the Security of Information Systems (ANSSI) BP-028 Minimal Level |

| 2.0 |

| CIS Red Hat Enterprise Linux 8 Benchmark for Level 2 - Server |

|

RHEL 8.9.0 および RHEL 8.9.2:2.0.0 |

| CIS Red Hat Enterprise Linux 8 Benchmark for Level 1 - Server |

|

RHEL 8.9.0 および RHEL 8.9.2:2.0.0 |

| CIS Red Hat Enterprise Linux 8 Benchmark for Level 1 - Workstation |

|

RHEL 8.9.0 および RHEL 8.9.2:2.0.0 |

| CIS Red Hat Enterprise Linux 8 Benchmark for Level 2 - Workstation |

|

RHEL 8.9.0 および RHEL 8.9.2:2.0.0 |

| Unclassified Information in Non-federal Information Systems and Organizations (NIST 800-171) |

| r1 |

| Australian Cyber Security Centre (ACSC) Essential Eight |

| バージョン付けなし |

| Health Insurance Portability and Accountability Act (HIPAA) |

| バージョン付けなし |

| Australian Cyber Security Centre (ACSC) ISM Official |

| バージョン付けなし |

| Protection Profile for General Purpose Operating Systems |

| 4.2.1 |

| PCI-DSS v3.2.1 Control Baseline for Red Hat Enterprise Linux 8 |

|

RHEL 8.9.0 および RHEL 8.9.2:3.2.1 |

| The Defense Information Systems Agency Security Technical Implementation Guide (DISA STIG) for Red Hat Enterprise Linux 8 |

|

RHEL 8.9.0 および RHEL 8.9.2:V1R11 |

| The Defense Information Systems Agency Security Technical Implementation Guide (DISA STIG) with GUI for Red Hat Enterprise Linux 8 |

|

RHEL 8.9.0 および RHEL 8.9.2:V1R11 |

表7.3 RHEL 8.8 で対応する SCAP セキュリティーガイドプロファイル

| プロファイル名 | プロファイル ID | ポリシーバージョン |

|---|---|---|

| Security of Information Systems (ANSSI) BP-028 Enhanced Level |

| 2.0 |

| French National Agency for the Security of Information Systems (ANSSI) BP-028 High Level |

| 2.0 |

| French National Agency for the Security of Information Systems (ANSSI) BP-028 Intermediary Level |

| 2.0 |

| French National Agency for the Security of Information Systems (ANSSI) BP-028 Minimal Level |

| 2.0 |

| CIS Red Hat Enterprise Linux 8 Benchmark for Level 2 - Server |

|

RHEL 8.8.0 および RHEL 8.8.5:2.0.0 |

| CIS Red Hat Enterprise Linux 8 Benchmark for Level 1 - Server |

|

RHEL 8.8.0 および RHEL 8.8.5:2.0.0 |

| CIS Red Hat Enterprise Linux 8 Benchmark for Level 1 - Workstation |

|

RHEL 8.8.0 および RHEL 8.8.5:2.0.0 |

| CIS Red Hat Enterprise Linux 8 Benchmark for Level 2 - Workstation |

|

RHEL 8.8.0 および RHEL 8.8.5:2.0.0 |

| Unclassified Information in Non-federal Information Systems and Organizations (NIST 800-171) |

| r1 |

| Australian Cyber Security Centre (ACSC) Essential Eight |

| バージョン付けなし |

| Health Insurance Portability and Accountability Act (HIPAA) |

| バージョン付けなし |

| Australian Cyber Security Centre (ACSC) ISM Official |

| バージョン付けなし |

| Protection Profile for General Purpose Operating Systems |

| 4.2.1 |

| PCI-DSS v3.2.1 Control Baseline for Red Hat Enterprise Linux 8 |

|

RHEL 8.8.0 および RHEL 8.8.5:3.2.1 |

| The Defense Information Systems Agency Security Technical Implementation Guide (DISA STIG) for Red Hat Enterprise Linux 8 |

|

RHEL 8.8.0 and RHEL 8.8.5:V1R9 |

| The Defense Information Systems Agency Security Technical Implementation Guide (DISA STIG) with GUI for Red Hat Enterprise Linux 8 |

|

RHEL 8.8.0 and RHEL 8.8.5:V1R9 |

表7.4 RHEL 8.7 で対応する SCAP セキュリティーガイドプロファイル

| プロファイル名 | プロファイル ID | ポリシーバージョン |

|---|---|---|

| Security of Information Systems (ANSSI) BP-028 Enhanced Level |

| 1.2 |

| French National Agency for the Security of Information Systems (ANSSI) BP-028 High Level |

| 1.2 |

| French National Agency for the Security of Information Systems (ANSSI) BP-028 Intermediary Level |

| 1.2 |

| French National Agency for the Security of Information Systems (ANSSI) BP-028 Minimal Level |

| 1.2 |

| CIS Red Hat Enterprise Linux 8 Benchmark for Level 2 - Server |

| 2.0.0 |

| CIS Red Hat Enterprise Linux 8 Benchmark for Level 1 - Server |

| 2.0.0 |

| CIS Red Hat Enterprise Linux 8 Benchmark for Level 1 - Workstation |

| 2.0.0 |

| CIS Red Hat Enterprise Linux 8 Benchmark for Level 2 - Workstation |

| 2.0.0 |

| Unclassified Information in Non-federal Information Systems and Organizations (NIST 800-171) |

| r1 |

| Australian Cyber Security Centre (ACSC) Essential Eight |

| バージョン付けなし |

| Health Insurance Portability and Accountability Act (HIPAA) |

| バージョン付けなし |

| Australian Cyber Security Centre (ACSC) ISM Official |

| バージョン付けなし |

| Protection Profile for General Purpose Operating Systems |

| 4.2.1 |

| PCI-DSS v3.2.1 Control Baseline for Red Hat Enterprise Linux 8 |

| 3.2.1 |

| The Defense Information Systems Agency Security Technical Implementation Guide (DISA STIG) for Red Hat Enterprise Linux 8 |

|

RHEL 8.7.0 および RHEL 8.7.1: V1R7 |

| The Defense Information Systems Agency Security Technical Implementation Guide (DISA STIG) with GUI for Red Hat Enterprise Linux 8 |

|

RHEL 8.7.0 および RHEL 8.7.1: V1R7 |

表7.5 RHEL 8.6 で対応する SCAP セキュリティーガイドプロファイル

| プロファイル名 | プロファイル ID | ポリシーバージョン |

|---|---|---|

| Security of Information Systems (ANSSI) BP-028 Enhanced Level |

|

RHEL 8.6.0 から 8.6.10: 1.2 |

| French National Agency for the Security of Information Systems (ANSSI) BP-028 High Level |

|

RHEL 8.6.0 から 8.6.10: 1.2 |

| French National Agency for the Security of Information Systems (ANSSI) BP-028 Intermediary Level |

|

RHEL 8.6.0 から 8.6.10: 1.2 |

| French National Agency for the Security of Information Systems (ANSSI) BP-028 Minimal Level |

|

RHEL 8.6.0 から 8.6.10: 1.2 |

| CIS Red Hat Enterprise Linux 8 Benchmark for Level 2 - Server |

|

RHEL 8.6.0 から RHEL 8.6.2:1.0.0 |

| CIS Red Hat Enterprise Linux 8 Benchmark for Level 1 - Server |

|

RHEL 8.6.0 から RHEL 8.6.2:1.0.0 |

| CIS Red Hat Enterprise Linux 8 Benchmark for Level 1 - Workstation |

|

RHEL 8.6.0 から RHEL 8.6.2:1.0.0 |

| CIS Red Hat Enterprise Linux 8 Benchmark for Level 2 - Workstation |

|

RHEL 8.6.0 から RHEL 8.6.2:1.0.0 |

| Unclassified Information in Non-federal Information Systems and Organizations (NIST 800-171) |

| r1 |

| Australian Cyber Security Centre (ACSC) Essential Eight |

| バージョン付けなし |

| Health Insurance Portability and Accountability Act (HIPAA) |

| バージョン付けなし |

| Australian Cyber Security Centre (ACSC) ISM Official |

| バージョン付けなし |

| Protection Profile for General Purpose Operating Systems |

| 4.2.1 |

| PCI-DSS v3.2.1 Control Baseline for Red Hat Enterprise Linux 8 |

| 3.2.1 |

| The Defense Information Systems Agency Security Technical Implementation Guide (DISA STIG) for Red Hat Enterprise Linux 8 |

|

RHEL 8.6.0:V1R5 |

| The Defense Information Systems Agency Security Technical Implementation Guide (DISA STIG) with GUI for Red Hat Enterprise Linux 8 |

|

RHEL 8.6.0:V1R5 |

表7.6 RHEL 8.5 で対応する SCAP セキュリティーガイドプロファイル

| プロファイル名 | プロファイル ID | ポリシーバージョン |

|---|---|---|

| Security of Information Systems (ANSSI) BP-028 Enhanced Level |

| 1.2 |

| French National Agency for the Security of Information Systems (ANSSI) BP-028 High Level |

| 1.2 |

| French National Agency for the Security of Information Systems (ANSSI) BP-028 Intermediary Level |

| 1.2 |

| French National Agency for the Security of Information Systems (ANSSI) BP-028 Minimal Level |

| 1.2 |

| CIS Red Hat Enterprise Linux 8 Benchmark for Level 2 - Server |

| 1.0.0 |

| CIS Red Hat Enterprise Linux 8 Benchmark for Level 1 - Server |

| 1.0.0 |

| CIS Red Hat Enterprise Linux 8 Benchmark for Level 1 - Workstation |

| 1.0.0 |

| CIS Red Hat Enterprise Linux 8 Benchmark for Level 2 - Workstation |

| 1.0.0 |

| Unclassified Information in Non-federal Information Systems and Organizations (NIST 800-171) |

| r1 |

| Australian Cyber Security Centre (ACSC) Essential Eight |

| バージョン付けなし |

| Health Insurance Portability and Accountability Act (HIPAA) |

| バージョン付けなし |

| Australian Cyber Security Centre (ACSC) ISM Official |

| バージョン付けなし |

| Protection Profile for General Purpose Operating Systems |

| 4.2.1 |

| PCI-DSS v3.2.1 Control Baseline for Red Hat Enterprise Linux 8 |

| 3.2.1 |

| The Defense Information Systems Agency Security Technical Implementation Guide (DISA STIG) for Red Hat Enterprise Linux 8 |

|

RHEL 8.5.0 から RHEL 8.5.3: V1R3 |

| The Defense Information Systems Agency Security Technical Implementation Guide (DISA STIG) with GUI for Red Hat Enterprise Linux 8 |

|

RHEL 8.5.0 から RHEL 8.5.3: V1R3 |

表7.7 RHEL 8.4 での SCAP セキュリティーガイドプロファイル

| プロファイル名 | プロファイル ID | ポリシーバージョン |

|---|---|---|

| Security of Information Systems (ANSSI) BP-028 Enhanced Level |

| 1.2 |

| French National Agency for the Security of Information Systems (ANSSI) BP-028 High Level |

| RHEL 8.4.4 以降: 1.2 |

| French National Agency for the Security of Information Systems (ANSSI) BP-028 Intermediary Level |

| 1.2 |

| French National Agency for the Security of Information Systems (ANSSI) BP-028 Minimal Level |

| 1.2 |

| CIS Red Hat Enterprise Linux 8 Benchmark for Level 2 - Server |

|

RHEL 8.4.3 以前:1.0.0 |

| CIS Red Hat Enterprise Linux 8 Benchmark for Level 1 - Server |

|

RHEL 8.4.4 〜 RHEL 8.4.10:1.0.1 |

| CIS Red Hat Enterprise Linux 8 Benchmark for Level 1 - Workstation |

|

RHEL 8.4.4 〜 RHEL 8.4.10:1.0.1 |

| CIS Red Hat Enterprise Linux 8 Benchmark for Level 2 - Workstation |

|

RHEL 8.4.4 〜 RHEL 8.4.10:1.0.1 |

| Unclassified Information in Non-federal Information Systems and Organizations (NIST 800-171) |

| r1 |

| Australian Cyber Security Centre (ACSC) Essential Eight |

| バージョン付けなし |

| Australian Cyber Security Centre (ACSC) ISM Official |

| RHEL 8.4.4 以降: バージョン付けなし |

| Health Insurance Portability and Accountability Act (HIPAA) |

| バージョン付けなし |

| Protection Profile for General Purpose Operating Systems |

| 4.2.1 |

| PCI-DSS v3.2.1 Control Baseline for Red Hat Enterprise Linux 8 |

| 3.2.1 |

| The Defense Information Systems Agency Security Technical Implementation Guide (DISA STIG) for Red Hat Enterprise Linux 8 |

|

RHEL 8.4.3 以前:V1R1 |

| The Defense Information Systems Agency Security Technical Implementation Guide (DISA STIG) with GUI for Red Hat Enterprise Linux 8 |

|

RHEL 8.4.4 〜 RHEL 8.4.7:V1R3 |

表7.8 RHEL 8.3 で SCAP セキュリティーガイドプロファイル

| プロファイル名 | プロファイル ID | ポリシーバージョン |

|---|---|---|

| CIS Red Hat Enterprise Linux 8 Benchmark |

| 1.0.0 |

| Unclassified Information in Non-federal Information Systems and Organizations (NIST 800-171) |

| r1 |

| Australian Cyber Security Centre (ACSC) Essential Eight |

| バージョン付けなし |

| Health Insurance Portability and Accountability Act (HIPAA) |

| バージョン付けなし |

| Protection Profile for General Purpose Operating Systems |

| 4.2.1 |

| PCI-DSS v3.2.1 Control Baseline for Red Hat Enterprise Linux 8 |

| 3.2.1 |

| [DRAFT] The Defense Information Systems Agency Security Technical Implementation Guide (DISA STIG) for Red Hat Enterprise Linux 8 |

| ドラフト |

表7.9 RHEL 8.2 で SCAP セキュリティーガイドプロファイル

| プロファイル名 | プロファイル ID | ポリシーバージョン |

|---|---|---|

| Australian Cyber Security Centre (ACSC) Essential Eight |

| バージョン付けなし |

| Protection Profile for General Purpose Operating Systems |

| 4.2.1 |

| PCI-DSS v3.2.1 Control Baseline for Red Hat Enterprise Linux 8 |

| 3.2.1 |

| [DRAFT] DISA STIG for Red Hat Enterprise Linux 8 |

| ドラフト |

表7.10 RHEL 8.1 で SCAP セキュリティーガイドプロファイル

| プロファイル名 | プロファイル ID | ポリシーバージョン |

|---|---|---|

| Protection Profile for General Purpose Operating Systems |

| 4.2.1 |

| PCI-DSS v3.2.1 Control Baseline for Red Hat Enterprise Linux 8 |

| 3.2.1 |

表7.11 RHEL 8.0 で対応する SCAP セキュリティーガイドプロファイル

| プロファイル名 | プロファイル ID | ポリシーバージョン |

|---|---|---|

| OSPP: 汎用オペレーティングシステムの保護プロファイル |

| ドラフト |

| PCI-DSS v3.2.1 Control Baseline for Red Hat Enterprise Linux 8 |

| 3.2.1 |

7.13. 関連情報

- RHEL の SCAP セキュリティーガイドで対応しているバージョン

-

OpenSCAP プロジェクトページ では、

oscapユーティリティー、その他のコンポーネント、および SCAP に関連するプロジェクトに関する詳細情報を提供しています。 -

SCAP Workbench プロジェクトページ は、

scap-workbenchアプリケーションに関する詳細情報を提供します。 - SCAP Security Guide (SSG) プロジェクトページ は、Red Hat Enterprise Linux の最新のセキュリティーコンテンツを提供します。

- セキュリティーコンプライアンスと脆弱性スキャンに OpenSCAP を使用する: RHEL でのコンプライアンスと脆弱性スキャンのための Security Content Automation Protocol (SCAP) 標準に基づくツールの実行に関するハンズオンラボ。

- Red Hat Security Demos: Creating Customized Security Policy Content to Automate Security Compliance - RHEL に含まれるツールを使用してセキュリティーコンプライアンスを自動化し、業界標準のセキュリティーポリシーとカスタムセキュリティーポリシーの両方に準拠するためのハンズオンラボ。トレーニングや、このラボ演習へのアクセスを希望する場合は、Red Hat アカウントチームにお問い合わせください。

- Red Hat Security Demos: Defend Yourself with RHEL Security Technologies - OpenSCAP を含む RHEL で利用可能な主要なセキュリティー技術を使用して、RHEL システムの全レベルでセキュリティーを実装する方法を学ぶためのハンズオンラボ。トレーニングや、このラボ演習へのアクセスを希望する場合は、Red Hat アカウントチームにお問い合わせください。

- National Institute of Standards and Technology (NIST) SCAP のページ では、SCAP の出版物、仕様、SCAP 検出プログラムなどの SCAP 関連の資料が多数提供されます。

- National Vulnerability Database (NVD) は、SCAP コンテンツおよびその他の SCAP 標準ベースの脆弱性管理データに関する最大のリポジトリーです。

- Red Hat OVAL コンテンツリポジトリー には、RHEL システムの脆弱性に対する OVAL 定義が含まれています。このページは、脆弱性の情報を得るために確認が推奨されるページです。

- MITRE CVE - これは、MITRE corporation が提供する既知のセキュリティー脆弱性のデータベースです。RHEL の場合は、Red Hat が提供する OVAL CVE コンテンツを使用することが推奨されます。

- MITRE OVAL - このページでは、MITRE corporation が提供する OVAL 関連のプロジェクトが紹介されています。OVAL の関連情報、たとえば OVAL 言語、数千にもなる OVAL 定義が用意された OVAL コンテンツのリポジトリーがあります。RHEL のスキャンには、Red Hat が提供する OVAL CVE コンテンツを使用することが推奨されます。

- Red Hat Satellite における セキュリティーコンプライアンスの管理 - このガイドセットでは、OpenSCAP を使用して複数のシステムでシステムセキュリティーを維持する方法などが説明されています。

第8章 AIDE で整合性の確認

Advanced Intrusion Detection Environment (AIDE) は、システムにファイルのデータベースを作成し、そのデータベースを使用してファイルの整合性を確保し、システムの侵入を検出するユーティリティーです。

8.1. AIDE のインストール

AIDE をインストールし、そのデータベースを開始するには、次の手順が必要です。

前提条件

-

AppStreamリポジトリーが有効になっている。

手順

aideパッケージをインストールします。# yum install aide初期データベースを生成します。

# aide --init注記デフォルト設定では、

aide --initコマンドは、/etc/aide.confファイルで定義するディレクトリーとファイルのセットのみを確認します。ディレクトリーまたはファイルを AIDE データベースに追加し、監視パラメーターを変更するには、/etc/aide.confを変更します。データベースの使用を開始するには、初期データベースのファイル名から末尾の

.newを削除します。# mv /var/lib/aide/aide.db.new.gz /var/lib/aide/aide.db.gz-

AIDE データベースの場所を変更するには、

/etc/aide.confファイルを編集し、DBDIR値を変更します。追加のセキュリティーのデータベース、設定、/usr/sbin/aideバイナリーファイルを、読み取り専用メディアなどの安全な場所に保存します。

8.2. AIDE を使用した整合性チェックの実行

前提条件

- AIDE が適切にインストールされ、データベースが初期化されている。AIDE のインストール を参照してください。

手順

手動でチェックを開始するには、以下を行います。

# aide --check Start timestamp: 2018-07-11 12:41:20 +0200 (AIDE 0.16) AIDE found differences between database and filesystem!! ... [trimmed for clarity]少なくとも、AIDE を毎週実行するようにシステムを設定します。最適な設定としては、AIDE を毎日実行します。たとえば、

cronコマンドを使用して毎日午前 04:05 に AIDE を実行するようにスケジュールするには、/etc/crontabファイルに次の行を追加します。05 4 * * * root /usr/sbin/aide --check

8.3. AIDE データベースの更新

Red Hat は、システムの変更 (パッケージの更新、設定ファイルの修正など) を確認してから、基本となる AIDE データベースを更新することを推奨します。

前提条件

- AIDE が適切にインストールされ、データベースが初期化されている。AIDE のインストール を参照してください。

手順

基本となる AIDE データベースを更新します。

# aide --updateaide --updateコマンドは、/var/lib/aide/aide.db.new.gzデータベースファイルを作成します。-

整合性チェックで更新したデータベースを使用するには、ファイル名から末尾の

.newを削除します。

8.4. ファイル整合性ツール:AIDE および IMA

Red Hat Enterprise Linux は、システム上のファイルとディレクトリーの整合性をチェックおよび保持するためのさまざまなツールを提供します。次の表は、シナリオに適したツールを決定するのに役立ちます。

表8.1 AIDE と IMA の比較

| 比較項目 | Advanced Intrusion Detection Environment (AIDE) | Integrity Measurement Architecture (IMA) |

|---|---|---|

| 確認対象 | AIDE は、システム上のファイルとディレクトリーのデータベースを作成するユーティリティーです。このデータベースは、ファイルの整合性をチェックし、侵入を検出するのに役立ちます。 | IMA は、以前に保存された拡張属性と比較してファイル測定値 (ハッシュ値) をチェックすることにより、ファイルが変更されているかどうかを検出します。 |

| 確認方法 | AIDE はルールを使用して、ファイルとディレクトリーの整合性状態を比較します。 | IMA は、ファイルハッシュ値を使用して侵入を検出します。 |

| 理由 | 検出- AIDE は、ルールを検証することにより、ファイルが変更されているかどうかを検出します。 | 検出と防止- IMA は、ファイルの拡張属性を置き換えることにより、攻撃を検出および防止します。 |

| 使用方法 | AIDE は、ファイルまたはディレクトリーが変更されたときに脅威を検出します。 | 誰かがファイル全体の変更を試みた時に、IMA は脅威を検出します。 |

| 範囲 | AIDE は、ローカルシステム上のファイルとディレクトリーの整合性をチェックします。 | IMA は、ローカルシステムとリモートシステムのセキュリティーを確保します。 |

8.5. 関連情報

-

aide(1)の man ページ - Kernel integrity subsystem

第9章 カーネル整合性サブシステムによるセキュリティーの強化

カーネル整合性サブシステムのコンポーネントを使用して、システムの保護を強化できます。関連するコンポーネントとその設定の詳細をご覧ください。

9.1. カーネル整合性サブシステム

整合性サブシステムは、システムデータの全体的な整合性を維持するカーネルの一部です。このサブシステムは、システムの状態を構築時と同じ状態に保つのに役立ちます。このサブシステムを使用すると、特定のシステムファイルの望ましくない変更を防ぐことができます。

カーネル整合性サブシステムは、2 つの主要なコンポーネントで設定されています。

- Integrity Measurement Architecture (IMA)

- IMA は、ファイルが実行されるか開かれるたびに、暗号学的にハッシュするか、暗号化キーで署名することにより、ファイルの内容を測定します。キーは、カーネルキーリングサブシステムに格納されます。