論理ボリュームの設定および管理

LVM の設定と管理

概要

Red Hat ドキュメントへのフィードバック (英語のみ)

Red Hat ドキュメントに関するご意見やご感想をお寄せください。また、改善点があればお知らせください。

Jira からのフィードバック送信 (アカウントが必要)

- Jira の Web サイトにログインします。

- 上部のナビゲーションバーで Create をクリックします。

- Summary フィールドにわかりやすいタイトルを入力します。

- Description フィールドに、ドキュメントの改善に関するご意見を記入してください。ドキュメントの該当部分へのリンクも追加してください。

- ダイアログの下部にある Create をクリックします。

第1章 論理ボリューム管理の概要

論理ボリュームマネージャー (LVM) は、抽象化レイヤーを物理ストレージ上に作成します。これは論理ストレージボリュームを作成するのに役立ちます。これにより、物理ストレージを直接使用する場合に比べて柔軟性が高まります。

さらに、ハードウェアストレージ設定がソフトウェアから隠されているため、アプリケーションを停止したりファイルシステムをアンマウントしたりすることなく、ボリュームのサイズを変更したり移動したりできます。したがって、運用コストが削減できます。

1.1. LVM のアーキテクチャー

以下は、LVM のコンポーネントです。

- 物理ボリューム

- 物理ボリューム (PV) は、LVM 使用用に指定されたパーティションまたはディスク全体です。詳細は、LVM 物理ボリュームの管理 を参照してください。

- ボリュームグループ

- ボリュームグループ (VG) は物理ボリューム (PV) の集合です。これにより、論理ボリュームに割り当て可能なディスク領域のプールが作成されます。詳細は、LVM ボリュームグループの管理 を参照してください。

- 論理ボリューム

- 論理ボリュームは使用可能なストレージデバイスを表します。詳細は、基本的な論理ボリューム管理 および 高度な論理ボリューム管理 を参照してください。

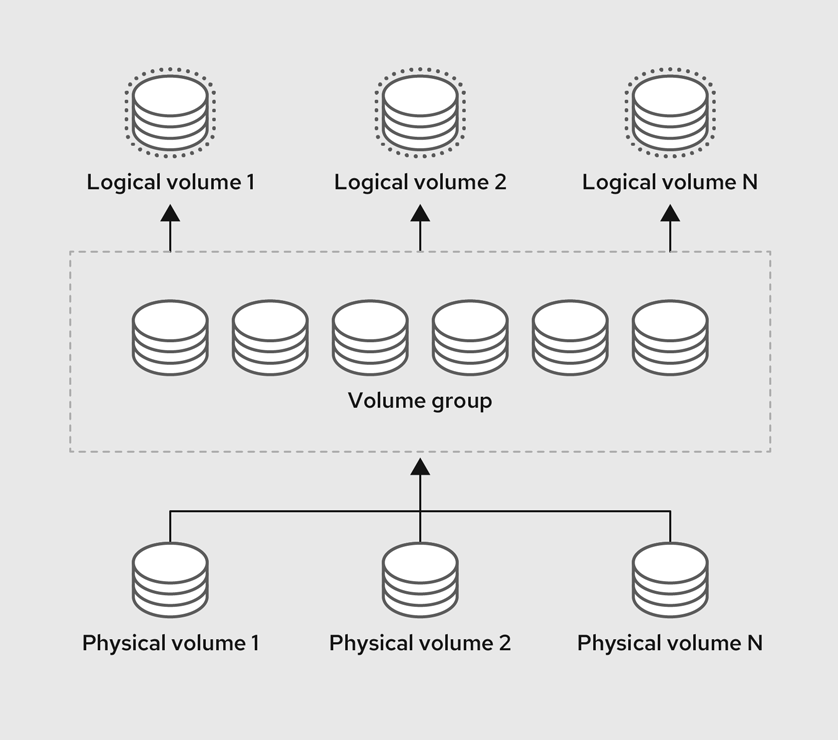

以下の図は、LVM のコンポーネントを示しています。

図1.1 LVM 論理ボリュームのコンポーネント

1.2. LVM の利点

物理ストレージを直接使用する場合と比較して、論理ボリュームには、以下のような利点があります。

- 容量の柔軟性

- 論理ボリュームを使用すると、ディスクとパーティションを 1 つの論理ボリュームに集約できます。この機能を使用すると、ファイルシステムを複数のデバイスにまたがって拡張でき、1 つの大きなファイルシステムとして扱うことができます。

- 便利なデバイスの命名

- 論理ストレージボリュームは、ユーザー定義のカスタマイズした名前で管理できます。

- サイズ変更可能なストレージボリューム

- 基になるデバイスを再フォーマットしたり、パーティションを再作成したりせずに、簡単なソフトウェアコマンドを使用して論理ボリュームのサイズを拡大または縮小できます。詳細は、論理ボリュームのサイズ変更 を参照してください。

- オンラインデータ移動

より新しく、高速で、耐障害性の高いストレージサブシステムをデプロイするには、

pvmoveコマンドを使用して、システムがアクティブな間にデータを移動できます。データは、ディスクが使用中の場合でもディスクに再配置できます。たとえば、ホットスワップ可能なディスクを削除する前に空にできます。データの移行方法の詳細は、

pvmoveman ページおよび ボリュームグループからの物理ボリュームの削除 を参照してください。- ストライプ化ボリューム

- 2 つ以上のデバイスにまたがってデータをストライプ化する論理ボリュームを作成できます。これにより、スループットが大幅に向上します。詳細は、ストライプ化論理ボリュームの作成 を参照してください。

- RAID ボリューム

- 論理ボリュームは、データの RAID を設定する際に便利な方法を提供します。これにより、デバイス障害に対する保護が可能になり、パフォーマンスが向上します。詳細は、RAID 論理ボリュームの設定 を参照してください。

- ボリュームスナップショット

- 論理ボリュームの特定の時点のコピーであるスナップショットを作成して、一貫性のあるバックアップを作成したり、実際のデータに影響を与えずに変更の影響をテストしたりすることができます。詳細は、論理ボリュームのスナップショットの管理 を参照してください。

- シンボリューム

- 論理ボリュームはシンプロビジョニングできます。これにより、利用可能な物理容量よりも大きな論理ボリュームを作成できます。詳細は、シン論理ボリュームの作成 を参照してください。

- キャッシュ

- キャッシュは、SSD などの高速デバイスを使用して論理ボリュームからデータをキャッシュし、パフォーマンスを向上させます。詳細は、論理ボリュームのキャッシュ を参照してください。

関連情報

第2章 LVM 物理ボリュームの管理

物理ボリューム (PV) は、LVM が使用する物理ストレージデバイスまたはストレージデバイス上のパーティションです。

初期化プロセス中に、LVM ディスクラベルとメタデータがデバイスに書き込まれます。これにより、LVM が論理ボリューム管理スキームの一部としてデバイスを追跡および管理できるようになります。

初期化後にメタデータのサイズを増やすことはできません。より大きなメタデータが必要な場合は、初期化プロセス中に適切なサイズを設定する必要があります。

初期化プロセスが完了したら、PV をボリュームグループ (VG) に割り当てることができます。この VG を論理ボリューム (LV) に分割できます。論理ボリュームは、オペレーティングシステムとアプリケーションがストレージに使用できる仮想ブロックデバイスです。

最適なパフォーマンスを確保するには、LVM 用にディスク全体を単一の PV としてパーティション設定してください。

2.1. LVM 物理ボリュームの作成

pvcreate コマンドを使用して、LVM で使用する物理ボリュームを初期化できます。

前提条件

- 管理アクセスがある。

-

lvm2パッケージがインストールされている。

手順

物理ボリュームとして使用するストレージデバイスを特定します。使用可能なすべてのストレージデバイスをリスト表示するには、次のコマンドを使用します。

$ lsblkLVM 物理ボリュームを作成します。

# pvcreate /dev/sdb/dev/sdb は、物理ボリュームとして初期化するデバイスの名前に置き換えます。

検証手順

作成された物理ボリュームを表示します。

# pvs PV VG Fmt Attr PSize PFree /dev/sdb lvm2 a-- 28.87g 13.87g

関連情報

-

システム上の

pvcreate(8)、pvdisplay(8)、pvs(8)、pvscan(8)、およびlvm(8)man ページ

2.2. LVM 物理ボリュームの削除

pvremove コマンドを使用して、LVM で使用する物理ボリュームを削除できます。

前提条件

- 管理アクセスがある。

手順

物理ボリュームをリスト表示して、削除するデバイスを特定します。

# pvs PV VG Fmt Attr PSize PFree /dev/sdb1 lvm2 --- 28.87g 28.87g

物理ボリュームを削除します。

# pvremove /dev/sdb1/dev/sdb1 は、物理ボリュームに関連付けられたデバイスの名前に置き換えます。

物理ボリュームがボリュームグループに含まれている場合は、まずボリュームグループから削除する必要があります。

ボリュームグループに複数の物理ボリュームが含まれている場合は、

vgreduceコマンドを使用します。# vgreduce VolumeGroupName /dev/sdb1VolumeGroupName は、ボリュームグループの名前に置き換えます。/dev/sdb1 は、デバイス名に置き換えます。

ボリュームグループに物理ボリュームが 1 つだけ含まれている場合は、

vgremoveコマンドを使用します。# vgremove VolumeGroupNameVolumeGroupName は、ボリュームグループの名前に置き換えます。

検証

物理ボリュームが削除されたことを確認します。

# pvs

関連情報

-

システム上の

pvremove(8)man ページ

2.3. Web コンソールで論理ボリュームの作成

論理ボリュームは物理ドライブとして動作します。RHEL 8 Web コンソールを使用して、ボリュームグループに LVM 論理ボリュームを作成できます。

前提条件

RHEL 8 Web コンソールがインストールされている。

手順は、Web コンソールのインストールおよび有効化 を参照してください。

-

cockpit-storagedパッケージがシステムにインストールされている。 - ボリュームグループが作成されている。

手順

RHEL 8 Web コンソールにログインします。

詳細は、Web コンソールへのログイン を参照してください。

- Storage をクリックします。

- Storage テーブルで、論理ボリュームを作成するボリュームグループをクリックします。

- Logical volume group ページで、LVM2 logical volumes セクションまでスクロールし、 をクリックします。

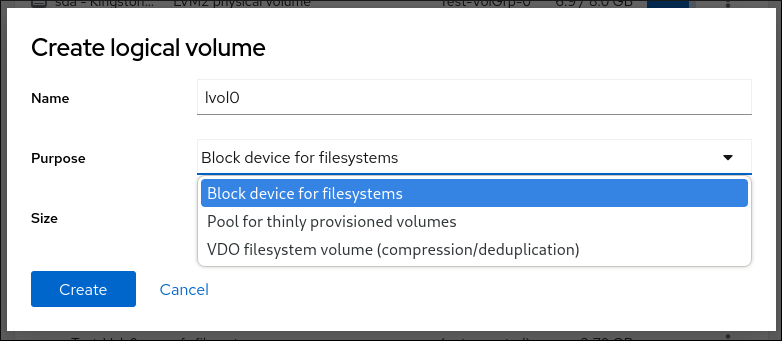

- Name フィールドに、新しい論理ボリュームの名前を入力します。名前にスペースを含めないでください。

ドロップダウンメニューで、Block device for filesystems を選択します。

この設定では、ボリュームグループに含まれるすべてのドライブの容量の合計に等しい最大ボリュームサイズを持つ論理ボリュームを作成できます。

論理ボリュームのサイズを定義します。以下を検討してください。

- この論理ボリュームを使用するシステムにどのぐらいの容量が必要か

- 作成する論理ボリュームの数

領域をすべて使用する必要はありません。必要な場合は、後で論理ボリュームを大きくすることができます。

をクリックします。

論理ボリュームが作成されます。論理ボリュームを使用するには、ボリュームをフォーマットしてマウントする必要があります。

検証

Logical volume ページで、LVM2 logical volumes セクションまでスクロールし、新しい論理ボリュームがリストされているかどうかを確認します。

2.4. Web コンソールで論理ボリュームのフォーマット

論理ボリュームは物理ドライブとして動作します。これらを使用するには、ファイルシステムでフォーマットする必要があります。

論理ボリュームをフォーマットすると、ボリューム上のすべてのデータが消去されます。

選択するファイルシステムにより、論理ボリュームに使用できる設定パラメーターが決まります。たとえば、XFS ファイルシステムはボリュームの縮小をサポートしていません。

前提条件

RHEL 8 Web コンソールがインストールされている。

手順は、Web コンソールのインストールおよび有効化 を参照してください。

-

cockpit-storagedパッケージがシステムにインストールされている。 - 論理ボリュームが作成されている。

- システムに対する root アクセス権限を持っている。

手順

RHEL 8 Web コンソールにログインします。

詳細は、Web コンソールへのログイン を参照してください。

- をクリックします。

- Storage テーブルで、論理ボリュームが作成されたボリュームグループをクリックします。

- Logical volume group ページで、LVM2 logical volumes セクションまでスクロールします。

- フォーマットするボリュームグループの横にあるメニューボタン をクリックします。

ドロップダウンメニューから を選択します。

- Name フィールドに、ファイルシステムの名前を入力します。

Mount Point フィールドにマウントパスを追加します。

ドロップダウンメニューで、ファイルシステムを選択します。

XFS ファイルシステムは大規模な論理ボリュームをサポートし、オンラインの物理ドライブを停止せずに、既存のファイルシステムの拡大および縮小を行うことができます。別のストレージの使用を希望しない場合は、このファイルシステムを選択したままにしてください。

XFS は、XFS ファイルシステムでフォーマットしたボリュームサイズを縮小することには対応していません。

ext4 ファイルシステムは以下に対応します。

- 論理ボリューム

- オンラインの物理ドライブを停止せずに切り替え

- ファイルシステムの拡張

- ファイルシステムの縮小

RHEL Web コンソールでディスク全体をゼロで書き換える場合は、Overwrite existing data with zeros チェックボックスをオンにします。このプログラムはディスク全体を調べるため、このオプションを使用すると遅くなりますが、安全性は高まります。ディスクにデータが含まれていて、上書きする必要がある場合は、このオプションを使用します。

Overwrite existing data with zeros チェックボックスを選択しない場合、RHEL Web コンソールはディスクヘッダーのみを書き換えます。これにより、フォーマットの速度が向上します。

論理ボリュームで暗号化を有効にする場合は、 ドロップダウンメニューで暗号化のタイプを選択します。

LUKS1 (Linux Unified Key Setup) または LUKS2 暗号化を使用したバージョンを選択できます。これを使用すると、パスフレーズを使用してボリュームを暗号化できます。

- ドロップダウンメニューで、システムの起動後に論理ボリュームをいつマウントするかを選択します。

- 必要な Mount options を選択します。

論理ボリュームをフォーマットします。

- ボリュームをフォーマットしてすぐにマウントする場合は、 をクリックします。

ボリュームをマウントせずにフォーマットする場合は、 をクリックします。

ボリュームのサイズや、選択するオプションによって、フォーマットに数分かかることがあります。

検証

Logical volume group ページで、LVM2 logical volumes セクションまでスクロールし、論理ボリュームをクリックして詳細と追加オプションを確認します。

- オプションを選択した場合は、論理ボリュームの行末にあるメニューボタンをクリックし、 を選択して論理ボリュームを使用します。

2.5. Web コンソールで論理ボリュームのサイズを変更する

RHEL 8 Web コンソールで論理ボリュームを拡張または縮小できます。この手順の例では、ボリュームをオフラインにせずに論理ボリュームのサイズを拡大および縮小する方法を説明します。

GFS2 または XFS のファイルシステムを含むボリュームを減らすことはできません。

前提条件

RHEL 8 Web コンソールがインストールされている。

手順は、Web コンソールのインストールおよび有効化 を参照してください。

-

cockpit-storagedパッケージがシステムにインストールされている。 - 論理ボリュームのサイズ変更に対応するファイルシステムを含む既存の論理ボリューム。

手順

- RHEL Web コンソールにログインします。

- をクリックします。

- Storage テーブルで、論理ボリュームが作成されたボリュームグループをクリックします。

Logical volume group ページで、LVM2 logical volumes セクションまでスクロールし、サイズを変更するボリュームグループの横にあるメニューボタン をクリックします。

メニューから Grow または Shrink を選択してボリュームのサイズを変更します。

ボリュームの増加:

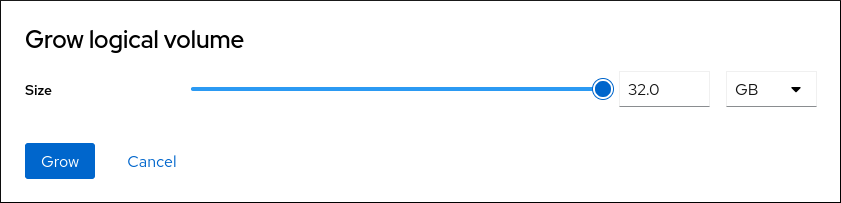

- ボリュームのサイズを増やすには、 を選択します。

Grow logical volume ダイアログボックスで、論理ボリュームのサイズを調整します。

をクリックします。

LVM はシステム停止を引き起こすことなく論理ボリュームを拡張します。

ボリュームの縮小:

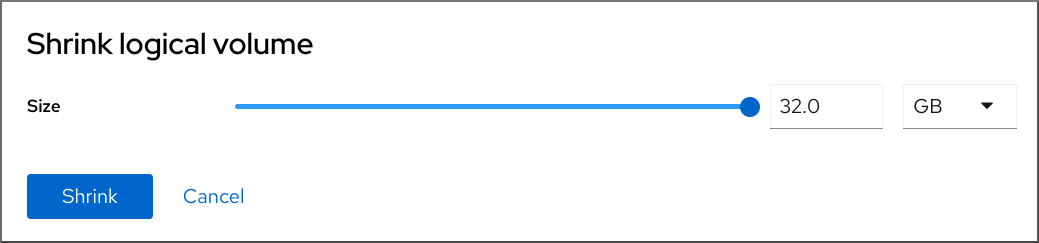

- ボリュームのサイズを縮小するには、 を選択します。

Shrink logical volume ダイアログボックスで、論理ボリュームのサイズを調整します。

をクリックします。

LVM はシステム停止を引き起こすことなく論理ボリュームを縮小します。

2.6. 関連情報

-

pvcreate(8)man ページ - parted でディスクにパーティションテーブルを作成

-

システム上の

parted(8)man ページ

第3章 LVM ボリュームグループの管理

ボリュームグループ (VG) を作成および使用すると、複数の物理ボリューム (PV) を 1 つのストレージエンティティーにまとめて管理およびサイズ変更できます。

LVM で割り当てることができる最小単位の領域のことを、エクステントといいます。物理エクステント (PE) と論理エクステント (LE) のデフォルトサイズは 4 MiB です。このサイズは設定可能です。すべてのエクステントは同じサイズです。

VG 内に論理ボリューム (LV) を作成すると、LVM が PV に物理エクステントを割り当てます。LV 内の論理エクステントは、VG 内の物理エクステントと 1 対 1 で対応します。LV を作成するために PE を指定する必要はありません。LVM は利用可能な PE を検出してそれらを組み合わせて、要求されたサイズの LV を作成します。

VG 内では、複数の LV を作成できます。各 LV は、従来のパーティションのように機能しますが、複数の物理ボリュームにまたがって動的にサイズを変更する機能を備えています。VG はディスク領域の割り当てを自動的に管理できます。

3.1. LVM ボリュームグループの作成

vgcreate コマンドを使用してボリュームグループ (VG) を作成できます。非常に大きいボリュームまたは非常に小さいボリュームのエクステントサイズを調整すると、パフォーマンスとストレージ効率を最適化できます。エクステントサイズは、VG を作成するときに指定できます。エクステントサイズを変更するには、ボリュームグループを再作成する必要があります。

前提条件

- 管理アクセスがある。

-

lvm2パッケージがインストールされている。 - 1 つ以上の物理ボリュームが作成されている。物理ボリュームの作成方法は、LVM 物理ボリュームの作成 を参照してください。

手順

VG に含める PV をリスト表示して特定します。

# pvsVG を作成します。

# vgcreate VolumeGroupName PhysicalVolumeName1 PhysicalVolumeName2VolumeGroupName は、作成するボリュームグループの名前に置き換えます。PhysicalVolumeName は、PV の名前に置き換えます。

VG を作成するときにエクステントサイズを指定するには、

-s ExtentSizeオプションを使用します。ExtentSize は、エクステントサイズに置き換えます。サイズの接尾辞を指定しなかった場合、このコマンドではデフォルトで MB が使用されます。

検証

VG が作成されたことを確認します。

# vgs VG #PV #LV #SN Attr VSize VFree VolumeGroupName 1 0 0 wz--n- 28.87g 28.87g

関連情報

-

システム上の

vgcreate(8)、vgs(8)、およびpvs(8)man ページ

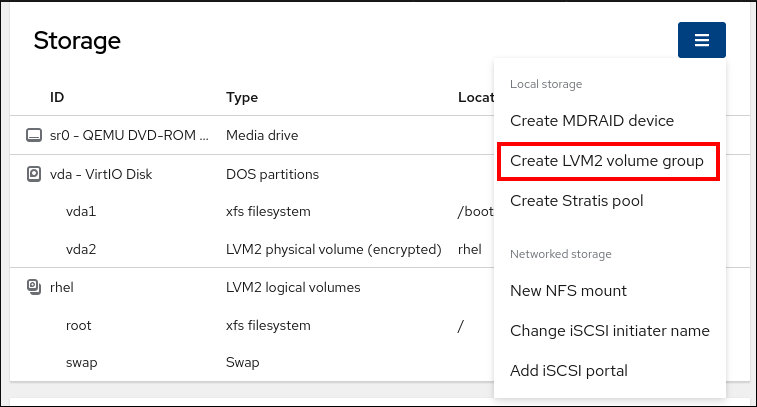

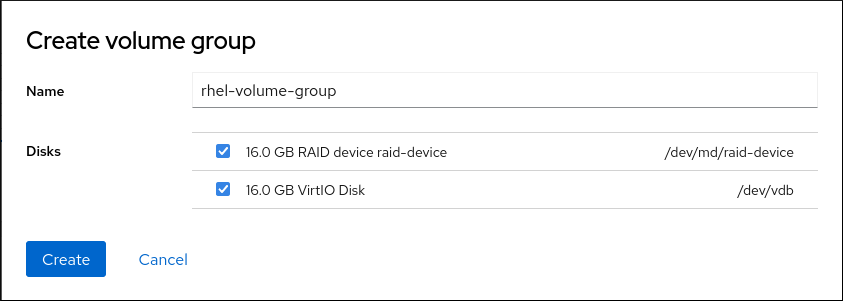

3.2. Web コンソールでボリュームグループの作成

1 つ以上の物理ドライブまたは他のストレージデバイスからボリュームグループを作成します。

論理ボリュームは、ボリュームグループから作成されます。各ボリュームグループに、複数の論理ボリュームを追加できます。

前提条件

RHEL 8 Web コンソールがインストールされている。

手順は、Web コンソールのインストールおよび有効化 を参照してください。

-

cockpit-storagedパッケージがシステムにインストールされている。 - ボリュームグループを作成する物理ドライブ、またはその他の種類のストレージデバイス。

手順

RHEL 8 Web コンソールにログインします。

詳細は、Web コンソールへのログイン を参照してください。

- をクリックします。

- Storage テーブルで、メニューボタンをクリックします。

ドロップダウンメニューから、Create LVM2 volume group を選択します。

- Name フィールドにボリュームグループの名前を入力します。名前にスペースを含めることはできません。

ボリュームグループを作成するために組み合わせるドライブを選択します。

RHEL Web コンソールは、未使用のブロックデバイスのみを表示します。リストにデバイスが表示されない場合は、そのデバイスがシステムで使用されていないことを確認するか、デバイスを空で未使用の状態にフォーマットしてください。使用されるデバイスには、たとえば次のようなものがあります。

- ファイルシステムでフォーマットしたデバイス

- 別のボリュームグループの物理ボリューム

- 別のソフトウェアの RAID デバイスのメンバーになる物理ボリューム

をクリックします。

ボリュームグループが作成されている。

検証

- Storage ページで、新しいボリュームグループが Storage テーブルにリストされているかどうかを確認します。

3.3. LVM ボリュームグループの名前変更

vgrename コマンドを使用してボリュームグループ (VG) の名前を変更できます。

前提条件

- 管理アクセスがある。

-

lvm2パッケージがインストールされている。 - 1 つ以上の物理ボリュームが作成されている。物理ボリュームの作成方法は、LVM 物理ボリュームの作成 を参照してください。

- ボリュームグループが作成されている。ボリュームグループの作成の詳細は、「LVM ボリュームグループの作成」 を参照してください。

手順

名前を変更する VG をリスト表示して特定します。

# vgsVG の名前を変更します。

# vgrename OldVolumeGroupName NewVolumeGroupNameOldVolumeGroupName は、VG の名前に置き換えます。NewVolumeGroupName は、VG の新しい名前に置き換えます。

検証

VG に新しい名前が付けられたことを確認します。

# vgs VG #PV #LV #SN Attr VSize VFree NewVolumeGroupName 1 0 0 wz--n- 28.87g 28.87g

関連情報

-

vgrename(8)、vgs(8)man ページ

3.4. LVM ボリュームグループの拡張

vgextend コマンドを使用して、物理ボリューム (PV) をボリュームグループ (VG) に追加できます。

前提条件

- 管理アクセスがある。

-

lvm2パッケージがインストールされている。 - 1 つ以上の物理ボリュームが作成されている。物理ボリュームの作成方法は、LVM 物理ボリュームの作成 を参照してください。

- ボリュームグループが作成されている。ボリュームグループの作成の詳細は、「LVM ボリュームグループの作成」 を参照してください。

手順

拡張する VG をリスト表示して特定します。

# vgsVG に追加する PV をリスト表示して特定します。

# pvsVG を拡張します。

# vgextend VolumeGroupName PhysicalVolumeNameVolumeGroupName は、VG の名前に置き換えます。PhysicalVolumeName は、PV の名前に置き換えます。

検証

VG に新しい PV が含まれていることを確認します。

# pvs PV VG Fmt Attr PSize PFree /dev/sda VolumeGroupName lvm2 a-- 28.87g 28.87g /dev/sdd VolumeGroupName lvm2 a-- 1.88g 1.88g

関連情報

-

vgextend(8)、vgs(8)、pvs(8)man ページ

3.5. LVM ボリュームグループの結合

vgmerge コマンドを使用して、既存の 2 つのボリュームグループ (VG) を結合できます。結合元ボリュームが結合先ボリュームにマージされます。

前提条件

- 管理アクセスがある。

-

lvm2パッケージがインストールされている。 - 1 つ以上の物理ボリュームが作成されている。物理ボリュームの作成方法は、LVM 物理ボリュームの作成 を参照してください。

- 2 つ以上のボリュームグループが作成されている。ボリュームグループの作成の詳細は、「LVM ボリュームグループの作成」 を参照してください。

手順

マージする VG をリスト表示して特定します。

# vgs VG #PV #LV #SN Attr VSize VFree VolumeGroupName1 1 0 0 wz--n- 28.87g 28.87g VolumeGroupName2 1 0 0 wz--n- 1.88g 1.88g結合元 VG を結合先 VG にマージします。

# vgmerge VolumeGroupName2 VolumeGroupName1VolumeGroupName2 は、結合元 VG の名前に置き換えます。VolumeGroupName1 は、結合先 VG の名前に置き換えます。

検証

VG に新しい PV が含まれていることを確認します。

# vgs VG #PV #LV #SN Attr VSize VFree VolumeGroupName1 2 0 0 wz--n- 30.75g 30.75g

関連情報

-

システム上の

vgmerge(8)man ページ

3.6. ボリュームグループからの物理ボリュームの削除

ボリュームグループ (VG) から未使用の物理ボリューム (PV) を削除するには、vgreduce コマンドを使用します。vgreduce コマンドは、空の物理ボリュームを 1 つまたは複数削除して、ボリュームグループの容量を縮小します。これにより、物理ボリュームが解放され、異なるボリュームグループで使用したり、システムから削除できるようになります。

手順

物理ボリュームがまだ使用中の場合は、同じボリュームグループから別の物理ボリュームにデータを移行します。

# pvmove /dev/vdb3 /dev/vdb3: Moved: 2.0% ... /dev/vdb3: Moved: 79.2% ... /dev/vdb3: Moved: 100.0%

既存のボリュームグループ内の他の物理ボリュームに空きエクステントが十分にない場合は、以下を行います。

/dev/vdb4 から、物理ボリュームを新規作成します。

# pvcreate /dev/vdb4 Physical volume "/dev/vdb4" successfully created

新しく作成した物理ボリュームをボリュームグループに追加します。

# vgextend VolumeGroupName /dev/vdb4 Volume group "VolumeGroupName" successfully extended

データを /dev/vdb3 から /dev/vdb4 に移動します。

# pvmove /dev/vdb3 /dev/vdb4 /dev/vdb3: Moved: 33.33% /dev/vdb3: Moved: 100.00%

ボリュームグループから物理ボリューム /dev/vdb3 を削除します。

# vgreduce VolumeGroupName /dev/vdb3 Removed "/dev/vdb3" from volume group "VolumeGroupName"

検証

/dev/vdb3 物理ボリュームが VolumeGroupName ボリュームグループから削除されていることを確認します。

# pvs PV VG Fmt Attr PSize PFree Used /dev/vdb1 VolumeGroupName lvm2 a-- 1020.00m 0 1020.00m /dev/vdb2 VolumeGroupName lvm2 a-- 1020.00m 0 1020.00m /dev/vdb3 lvm2 a-- 1020.00m 1008.00m 12.00m

関連情報

-

システム上の

vgreduce(8)、pvmove(8)、およびpvs(8)man ページ

3.7. LVM ボリュームグループの分割

この物理ボリュームに未使用領域が十分にあれば、新たにディスクを追加しなくてもボリュームグループを作成できます。

初期設定では、ボリュームグループ VolumeGroupName1 は、/dev/vdb1、/dev/vdb2、および /dev/vdb3 で構成されます。この手順を完了すると、ボリュームグループ VolumeGroupName1 は /dev/vdb1 と /dev/vdb2 で構成され、2 番目のボリュームグループ VolumeGroupName2 は /dev/vdb3 で構成されます。

前提条件

-

ボリュームグループに十分な空き領域がある。

vgscanコマンドを使用すると、現在ボリュームグループで利用可能な空き領域の容量を確認できます。 -

既存の物理ボリュームの空き容量に応じて、

pvmoveコマンドを使用して、使用されている物理エクステントをすべて他の物理ボリュームに移動します。詳細は、ボリュームグループからの物理ボリュームの削除 を参照してください。

手順

既存のボリュームグループ VolumeGroupName1 を、新しいボリュームグループ VolumeGroupName2 に分割します。

# vgsplit VolumeGroupName1 VolumeGroupName2 /dev/vdb3 Volume group "VolumeGroupName2" successfully split from "VolumeGroupName1"

注記既存のボリュームグループを使用して論理ボリュームを作成した場合は、次のコマンドを実行して論理ボリュームを非アクティブにします。

# lvchange -a n /dev/VolumeGroupName1/LogicalVolumeName2 つのボリュームグループの属性を表示します。

# vgs VG #PV #LV #SN Attr VSize VFree VolumeGroupName1 2 1 0 wz--n- 34.30G 10.80G VolumeGroupName2 1 0 0 wz--n- 17.15G 17.15G

検証

新しく作成したボリュームグループ VolumeGroupName2 が、/dev/vdb3 物理ボリュームで構成されていることを確認します。

# pvs PV VG Fmt Attr PSize PFree Used /dev/vdb1 VolumeGroupName1 lvm2 a-- 1020.00m 0 1020.00m /dev/vdb2 VolumeGroupName1 lvm2 a-- 1020.00m 0 1020.00m /dev/vdb3 VolumeGroupName2 lvm2 a-- 1020.00m 1008.00m 12.00m

関連情報

-

システム上の

vgsplit(8)、vgs(8)、およびpvs(8)man ページ

3.8. ボリュームグループを別のシステムへ移動

次のコマンドを使用して、LVM ボリュームグループ (VG) 全体を別のシステムに移動できます。

vgexport- 既存のシステムでこのコマンドを使用して、システムから非アクティブな VG にアクセスできないようにします。VG にアクセスできなくなったら、その物理ボリューム (PV) の接続を解除できます。

vgimport- 他のシステムでこのコマンドを使用して、新しいシステムで、古いシステムで非アクティブだった VG にアクセスできるようにします。

前提条件

- 移動するボリュームグループ内のアクティブなボリュームのファイルにアクセスしているユーザーがいない。

手順

LogicalVolumeName 論理ボリュームをアンマウントします。

# umount /dev/mnt/LogicalVolumeNameボリュームグループ内のすべての論理ボリュームを非アクティブ化します。これにより、ボリュームグループでこれ以上の動作が発生しないようにします。

# vgchange -an VolumeGroupName vgchange -- volume group "VolumeGroupName" successfully deactivatedボリュームグループをエクスポートして、削除元のシステムがボリュームグループにアクセスできないようにします。

# vgexport VolumeGroupName vgexport -- volume group "VolumeGroupName" successfully exportedエクスポートされたボリュームグループを表示します。

# pvscan PV /dev/sda1 is in exported VG VolumeGroupName [17.15 GB / 7.15 GB free] PV /dev/sdc1 is in exported VG VolumeGroupName [17.15 GB / 15.15 GB free] PV /dev/sdd1 is in exported VG VolumeGroupName [17.15 GB / 15.15 GB free] ...- システムをシャットダウンし、ボリュームグループを構成するディスクを取り外し、新しいシステムに接続します。

ディスクを新しいシステムに接続し、ボリュームグループをインポートして、新しいシステムからアクセスできるようにします。

# vgimport VolumeGroupName注記vgimportコマンドの--force引数を使用すると、物理ボリュームがないボリュームグループをインポートし、その後vgreduce --removemissingコマンドを実行できます。ボリュームグループをアクティブ化します。

# vgchange -ay VolumeGroupNameファイルシステムをマウントして使用できるようにします。

# mkdir -p /mnt/VolumeGroupName/users # mount /dev/VolumeGroupName/users /mnt/VolumeGroupName/users

関連情報

-

システム上の

vgimport(8)、vgexport(8)、およびvgchange(8)man ページ

3.9. LVM ボリュームグループの削除

vgremove コマンドを使用して、既存のボリュームグループを削除できます。削除できるボリュームグループは、論理ボリュームが含まれていないものだけです。

前提条件

- 管理アクセスがある。

手順

ボリュームグループに論理ボリュームが含まれていないことを確認します。

# vgs -o vg_name,lv_count VolumeGroupName VG #LV VolumeGroupName 0

VolumeGroupName は、ボリュームグループの名前に置き換えます。

ボリュームグループを削除します。

# vgremove VolumeGroupNameVolumeGroupName は、ボリュームグループの名前に置き換えます。

関連情報

-

システム上の

vgs(8)、vgremove(8)man ページ

3.10. クラスター環境での LVM ボリュームグループの削除

クラスター環境では、LVM は lockspace <qualifier> を使用して、複数のマシン間で共有されるボリュームグループへのアクセスを調整します。ボリュームグループを削除する前に lockspace を停止し、削除プロセス中に他のノードがボリュームグループにアクセスしたり変更したりしないようにする必要があります。

前提条件

- 管理アクセスがある。

- ボリュームグループには論理ボリュームがありません。

手順

ボリュームグループに論理ボリュームが含まれていないことを確認します。

# vgs -o vg_name,lv_count VolumeGroupName VG #LV VolumeGroupName 0

VolumeGroupName は、ボリュームグループの名前に置き換えます。

ボリュームグループを削除するノードを除くすべてのノードで

lockspaceを停止します。# vgchange --lockstop VolumeGroupNameVolumeGroupName は、ボリュームグループの名前に置き換えます。ロックが停止するまで待ちます。

ボリュームグループを削除します。

# vgremove VolumeGroupNameVolumeGroupName は、ボリュームグループの名前に置き換えます。

関連情報

-

vgremove(8)、vgchange(8)man ページ

第4章 基本的な論理ボリューム管理

LVM を使用すると、次のタスクを実行できます。

- 新しい論理ボリュームを作成してシステムのストレージ機能を拡張する

- データの増大に対応するために既存のボリュームとシンプールを拡張する

- 整理しやすくするためにボリュームの名前を変更する

- ボリュームを減らして未使用の領域を解放する

- 不要になったボリュームを安全に削除する

- ボリュームをアクティブ化または非アクティブ化して、システムのデータへのアクセスを制御する

4.1. 論理ボリューム機能の概要

論理ボリュームマネージャー (LVM) を使用すると、従来のパーティションスキームでは実現できない柔軟かつ効率的な方法でディスクストレージを管理できます。以下は、ストレージの管理と最適化に使用される主要な LVM 機能の概要です。

- 連結

- 連結では、1 つ以上の物理ボリュームの領域を 1 つの論理ボリュームに結合し、物理ストレージを効果的にマージします。

- ストライピング

- ストライピングは、データを複数の物理ボリュームに分散することで、データの I/O 効率を最適化します。並列 I/O 操作を可能にすることで、シーケンシャルな読み取りおよび書き込みのパフォーマンスを向上させます。

- RAID

- LVM は、RAID レベル 0、1、4、5、6、10 に対応します。RAID 論理ボリュームを作成するとき、LVM は、データまたはアレイ内のパリティーサブボリュームごとに、サイズが 1 エクステントのメタデータサブボリュームを作成します。

- シンプロビジョニング

- シンプロビジョニングを使用すると、使用可能な物理ストレージよりも大きい論理ボリュームを作成できます。シンプロビジョニングでは、事前に決められた量ではなく、実際の使用量に基づいてシステムがストレージを動的に割り当てます。

- スナップショット

- LVM スナップショットを使用すると、論理ボリュームの特定時点のコピーを作成できます。スナップショットは、最初は空の状態です。元の論理ボリュームに変更が発生すると、スナップショットがコピーオンライト (CoW) により変更前の状態をキャプチャーします。変更があった場合にのみ、元の論理ボリュームの状態を保持するためにサイズが増加します。

- キャッシュ

- LVM は、高速ブロックデバイス (SSD ドライブなど) を、大規模で低速なブロックデバイスのライトバックまたはライトスルーのキャッシュとして使用することに対応します。既存の論理ボリュームのパフォーマンスを改善するためにキャッシュ論理ボリュームを作成したり、大規模で低速なデバイスと共に小規模で高速なデバイスで構成される新規のキャッシュ論理ボリュームを作成したりできます。

4.2. 論理ボリュームの作成

LVM は、物理レイヤーを論理ボリュームに抽象化し、ニーズに応じて作成および調整することで、ディスクストレージを柔軟な方法で処理します。

4.2.1. リニア (シック) 論理ボリュームの作成

リニア論理ボリューム (LV) を使用すると、複数の物理ストレージユニットを 1 つの仮想ストレージ領域に結合できます。リニア LV は、データ要件に合わせて、簡単に拡張または縮小できます。

前提条件

- 管理アクセスがある。

-

lvm2パッケージがインストールされている。 - ボリュームグループが作成されている。詳細は、LVM ボリュームグループの作成 を参照してください。

手順

ボリュームグループの名前とサイズをリスト表示します。

# vgs -o vg_name,vg_size VG VSize VolumeGroupName 30.75gリニア LV を作成します。

# lvcreate --name LogicalVolumeName --size VolumeSize VolumeGroupNameLogicalVolumeName は、LV の名前に置き換えます。VolumeSize は、LV のサイズに置き換えます。サイズの接尾辞が指定されていない場合、このコマンドではデフォルトで MB が使用されます。VolumeGroupName は、ボリュームグループの名前に置き換えます。

検証

リニア LV が作成されたことを確認します。

# lvs -o lv_name,seg_type LV Type LogicalVolumeName linear

関連情報

-

vgs(8)、lvs(8)、lvcreate(8)man ページ

4.2.2. storage RHEL システムロールを使用して論理ボリュームを作成またはサイズ変更する

storage ロールを使用して、次のタスクを実行します。

- 多数のディスクで構成されるボリュームグループに LVM 論理ボリュームを作成する

- LVM 上の既存のファイルシステムのサイズを変更する

- LVM ボリュームのサイズをプールの合計サイズのパーセンテージで表す

ボリュームグループが存在しない場合、このロールによって作成されます。ボリュームグループ内に論理ボリュームが存在する場合に、そのサイズが Playbook で指定されたサイズと一致しないと、サイズが変更されます。

論理ボリュームを縮小する場合、データの損失を防ぐために、その論理ボリューム上のファイルシステムによって、縮小する論理ボリューム内の領域が使用されていないことを確認する必要があります。

前提条件

- コントロールノードと管理対象ノードの準備が完了している。

- 管理対象ノードで Playbook を実行できるユーザーとしてコントロールノードにログインしている。

-

管理対象ノードへの接続に使用するアカウントに、そのノードに対する

sudo権限がある。

手順

次の内容を含む Playbook ファイル (例:

~/playbook.yml) を作成します。--- - name: Manage local storage hosts: managed-node-01.example.com tasks: - name: Create logical volume ansible.builtin.include_role: name: rhel-system-roles.storage vars: storage_pools: - name: myvg disks: - sda - sdb - sdc volumes: - name: mylv size: 2G fs_type: ext4 mount_point: /mnt/dataサンプル Playbook で指定されている設定は次のとおりです。

size: <size>- 単位 (GiB など) またはパーセンテージ (60% など) を使用してサイズを指定する必要があります。

Playbook で使用されるすべての変数の詳細は、コントロールノードの

/usr/share/ansible/roles/rhel-system-roles.storage/README.mdファイルを参照してください。Playbook の構文を検証します。

$ ansible-playbook --syntax-check ~/playbook.ymlこのコマンドは構文を検証するだけであり、有効だが不適切な設定から保護するものではないことに注意してください。

Playbook を実行します。

$ ansible-playbook ~/playbook.yml

検証

指定したボリュームが作成されたこと、または要求したサイズに変更されたことを確認します。

# ansible managed-node-01.example.com -m command -a 'lvs myvg'

関連情報

-

/usr/share/ansible/roles/rhel-system-roles.storage/README.mdファイル -

/usr/share/doc/rhel-system-roles/storage/ディレクトリー

4.2.3. ストライプ化論理ボリュームの作成

ストライプ化論理ボリューム (LV) を使用すると、複数の物理ボリューム (PV) にデータを分散できます。そのため、複数のディスクの帯域幅を同時に利用して、読み取りおよび書き込み速度を向上できます。

ストライプ化 LV を作成するときは、ストライプの数とサイズを考慮することが重要です。ストライプの数は、データが分散される PV の数です。ストライプの数を増やすと、複数のディスクを同時に利用してパフォーマンスを向上できます。ストライプのサイズは、次のディスクに移動するまでにストライプセット内の各ディスクに書き込まれるデータチャンクのサイズであり、キロバイト (KB) 単位で指定されます。最適なストライプのサイズは、ワークロードとファイルシステムのブロックサイズによって異なります。デフォルトは 64KB ですが、調整可能です。

前提条件

- 管理アクセスがある。

手順

ボリュームグループの名前とサイズをリスト表示します。

# vgs -o vg_name,vg_size VG VSize VolumeGroupName 30.75gストライプ化 LV を作成します。

# lvcreate --stripes NumberOfStripes --stripesize StripeSize --size LogicalVolumeSize --name LogicalVolumeName VolumeGroupNameNumberOfStripes は、ストライプの数に置き換えます。StripeSize は、キロバイト単位のストライプのサイズに置き換えます。

--stripesizeは必須オプションではありません。ストライプのサイズを指定しなかった場合、デフォルトで 64 KB になります。LogicalVolumeName は、LV の名前に置き換えます。VolumeGroupName は、ボリュームグループの名前に置き換えます。

検証

ストライプ化 LV が作成されたことを確認します。

# lvs -o lv_name,seg_type LV Type LogicalVolumeName striped

関連情報

-

vgs(8)lvs(8)、lvcreate(8)man ページ

4.2.4. RAID 論理ボリュームの作成

RAID 論理ボリュームを使用すると、複数のディスクを使用して冗長性とパフォーマンスを確保できます。LVM は、RAID0、RAID1、RAID4、RAID5、RAID6、RAID10 など、さまざまな RAID レベルをサポートしています。

LVM を使用すると、ストライプ化 RAID (RAID0、RAID4、RAID5、RAID6)、ミラー化 RAID (RAID1)、またはその両方の組み合わせ (RAID10) を作成できます。

RAID 4、RAID 5、および RAID 6 は、ディスク障害発生時に失われた情報を再構築するのに使用できるパリティーデータを保存することにより、フォールトトレランスを提供します。

RAID LV を作成するときは、各ストライプを個別の PV に配置します。ストライプの数は、ボリュームグループ (VG) 内に存在する PV の数と同じです。

| RAID レベル | 型 | パリティー | デバイスの最小数 | ストライプの最小数 |

|---|---|---|---|---|

| RAID0 | ストライピング | なし | 2 | 2 |

| RAID1 | ミラーリング | なし | 2 | - |

| RAID4 | ストライピング | 最初のデバイスを使用してパリティーを保存する | 3 | 2 |

| RAID5 | ストライピング | 1 つの追加デバイスを使用してパリティーを保存する | 3 | 2 |

| RAID6 | ストライピング | 2 つの追加デバイスを使用してパリティーを保存する | 5 | 3 |

| RAID10 | ストライピングとミラーリング | なし | 4 | 2 |

前提条件

- 管理アクセスがある。

手順

ボリュームグループの名前とサイズをリスト表示します。

# vgs -o vg_name,vg_size VG VSize VolumeGroupName 30.75gRAID LV を作成します。

ストライプ化 RAID を作成するには、次を使用します。

# lvcreate --type raidlevel --stripes NumberOfStripes --stripesize StripeSize --size Size --name LogicalVolumeName VolumeGroupNamelevel は、RAID レベル 0、4、5、または 6 に置き換えます。NumberOfStripes は、ストライプの数に置き換えます。StripeSize は、キロバイト単位のストライプのサイズに置き換えます。Size は、LV のサイズに置き換えます。LogicalVolumeName は、LV の名前に置き換えます。

ミラー化 RAID を作成するには、次を使用します。

# lvcreate --type raid1 --mirrors MirrorsNumber --size Size --name LogicalVolumeName VolumeGroupNameMirrorsNumber は、ミラーの数に置き換えます。Size は、LV のサイズに置き換えます。LogicalVolumeName は、LV の名前に置き換えます。

ミラー化およびストライプ化 RAID を作成するには、次を使用します。

# lvcreate --type raid10 --mirrors MirrorsNumber --stripes NumberOfStripes --stripesize StripeSize --size Size --name LogicalVolumeName VolumeGroupNameMirrorsNumber は、ミラーの数に置き換えます。NumberOfStripes は、ストライプの数に置き換えます。StripeSize は、キロバイト単位のストライプのサイズに置き換えます。Size は、LV のサイズに置き換えます。LogicalVolumeName は、LV の名前に置き換えます。

検証

RAID LV が作成されたことを確認します。

# lvs -o lv_name,seg_type LV Type LogicalVolumeName raid0

関連情報

-

lvmraid(7)、vgs(8)、lvs(8)、lvcreate(8)man ページ

4.2.5. シン論理ボリュームの作成

シンプロビジョニングでは、ボリュームグループ (VG) の物理エクステント (PE) が割り当てられて、特定の物理サイズのシンプールが作成されます。このシンプールから、論理ボリューム (LV) が、プールの物理容量によって制限されることなく、仮想サイズに基づいて割り当てられます。これにより、すべてのシン LV の合計仮想サイズがシンプールの物理容量を超えると、各シン LV の仮想サイズがシンプールの実際のサイズを超え、オーバープロビジョニングが発生する可能性があります。したがって、容量不足やシステム停止を回避するには、論理的な使用量と物理的な使用量の両方を注意深く監視することが重要です。

シンプロビジョニングは、必要に応じて領域を割り当て、初期コストを削減し、リソースの使用率を向上させることで、ストレージ効率を最適化します。ただし、シン LV を使用する場合は、次の欠点に注意してください。

- 不適切な破棄処理により、未使用のストレージ領域の解放がブロックされ、時間が経過すると領域がすべて割り当てられる可能性があります。

- スナップショットのあるファイルシステムでは、コピーオンライト (CoW) 操作が遅くなる可能性があります。

- データブロックが複数のファイルシステム間で混在する可能性があるため、ランダムアクセスが制限されることがあります。

前提条件

- 管理アクセスがある。

- 物理ボリュームが作成されている。詳細は、LVM 物理ボリュームの作成 を参照してください。

- ボリュームグループが作成されている。詳細は、LVM ボリュームグループの作成 を参照してください。

- 論理ボリュームが作成されている。詳細は、論理ボリュームの作成 を参照してください。

手順

ボリュームグループの名前とサイズをリスト表示します。

# vgs -o vg_name,vg_size VG VSize VolumeGroupName 30.75gシンプールを作成します。

# lvcreate --type thin-pool --size PoolSize --name ThinPoolName VolumeGroupNamePoolSize は、シンプールが使用できるディスク領域の最大量に置き換えます。ThinPoolName は、シンプールの名前に置き換えます。VolumeGroupName は、ボリュームグループの名前に置き換えます。

シン LV を作成します。

# lvcreate --type thin --virtualsize MaxVolumeSize --name ThinVolumeName --thinpool ThinPoolName VolumeGroupNameMaxVolumeSize は、シンプール内でボリュームが拡張できる最大サイズに置き換えます。ThinPoolName は、シンプールの名前に置き換えます。VolumeGroupName は、ボリュームグループの名前に置き換えます。

注記同じシンプール内に他のシン LV を作成できます。

検証

シン LV が作成されたことを確認します。

# lvs -o lv_name,seg_type LV Type ThinPoolName thin-pool ThinVolumeName thin

関連情報

-

lvs(8)、lvcreate(8)man ページ

4.3. 論理ボリュームのサイズ変更

論理ボリュームマネージャー (LVM) を使用すると、論理ボリューム (LV) に保存されているデータに影響を与えることなく、必要に応じて LV のサイズを変更できます。

4.3.1. リニア論理ボリュームの拡張

lvextend コマンドを使用して、リニア (シック) LV とそのスナップショットを拡張できます。

前提条件

- 管理アクセスがある。

手順

ボリュームグループに、LV を拡張するのに十分な容量があることを確認します。

# lvs -o lv_name,lv_size,vg_name,vg_size,vg_free LV LSize VG VSize VFree LogicalVolumeName 1.49g VolumeGroupName 30.75g 29.11gリニア LV を拡張し、ファイルシステムのサイズを変更します。

# lvextend --size +AdditionalSize --resizefs VolumeGroupName/LogicalVolumeNameAdditionalSize は、LV に追加する容量に置き換えます。デフォルトの測定単位はメガバイトですが、他の単位を指定することもできます。VolumeGroupName は、ボリュームグループの名前に置き換えます。LogicalVolumeName は、シンボリュームの名前に置き換えます。

検証

リニア LV が拡張されたことを確認します。

# lvs -o lv_name,lv_size LV LSize NewLogicalVolumeName 6.49g

4.3.2. シン論理ボリュームの拡張

lvextend コマンドを使用して、シン論理ボリューム (LV) を拡張できます。

前提条件

- 管理アクセスがある。

手順

追加する予定のデータに対して、シンプールに十分な容量があることを確認します。

# lvs -o lv_name,lv_size,data_percent LV LSize Data% MyThinPool 20.10g 3.21 ThinVolumeName 1.10g 4.88シン LV を拡張し、ファイルシステムのサイズを変更します。

# lvextend --size +AdditionalSize --resizefs VolumeGroupName/ThinVolumeNameAdditionalSize は、LV に追加する容量に置き換えます。デフォルトの測定単位はメガバイトですが、他の単位を指定することもできます。VolumeGroupName は、ボリュームグループの名前に置き換えます。ThinVolumeName は、シンボリュームの名前に置き換えます。

検証

シン LV が拡張されたことを確認します。

# lvs -o lv_name,lv_size,data_percent LV LSize Data% MyThinPool 20.10g 3.21 ThinVolumeName 6.10g 0.43

4.3.3. シンプールの拡張

シン論理ボリュームの仮想サイズがシンプールの物理容量を超え、オーバープロビジョニングが発生する可能性があります。容量不足を防ぐために、シンプールの容量を監視し、定期的に拡張する必要があります。

data_percent メトリクスは、シンプールが現在使用している割り当て済みのデータ領域の割合を示します。metadata_percent メトリクスは、シンプール内のマッピングを管理するために不可欠なメタデータの保存に使用される領域の割合を示します。

効率的なストレージ管理を実現し、容量の問題を回避するには、これらのメトリクスを監視することが不可欠です。

LVM には、必要に応じてデータまたはメタデータの容量を手動で拡張するオプションが用意されています。または、監視を有効にして、シンプールの拡張を自動化することもできます。

4.3.3.1. シンプールの手動拡張

論理ボリュームマネージャー (LVM) には、データセグメント、メタデータセグメント、またはシンプールを手動で拡張するオプションが用意されています。

4.3.3.1.1. シンプールの拡張

lvextend コマンドを使用してシンプールを拡張できます。

前提条件

- 管理アクセスがある。

手順

データとメタデータの使用中の領域を表示します。

# lvs -o lv_name,seg_type,data_percent,metadata_percent LV Type Data% Meta% ThinPoolName thin-pool 97.66 26.86 ThinVolumeName thin 48.80シンプールを拡張します。

# lvextend -L Size VolumeGroupName/ThinPoolNameSize は、シンプールの新しいサイズに置き換えます。VolumeGroupName は、ボリュームグループの名前に置き換えます。ThinPoolName は、シンプールの名前に置き換えます。

データサイズが拡張されます。必要に応じてメタデータのサイズが拡張されます。

検証

シンプールが拡張されたことを確認します。

# lvs -o lv_name,seg_type,data_percent,metadata_percent LV Type Data% Meta% ThinPoolName thin-pool 24.41 16.93 ThinVolumeName thin 24.41

関連情報

-

lvs(8)、lvextend(8)man ページ -

lvs -o help

4.3.3.1.2. シンプールのデータセグメントの拡張

lvextend コマンドを使用して、data_percent セグメントを拡張できます。

前提条件

- 管理アクセスがある。

手順

data_percentセグメントを表示します。# lvs -o lv_name,seg_type,data_percent LV Type Data% ThinPoolName thin-pool 93.87data_percentセグメントを拡張します。# lvextend -L Size VolumeGroupName/ThinPoolName_tdataSize は、データセグメントのサイズに置き換えます。VolumeGroupName は、ボリュームグループの名前に置き換えます。ThinPoolName は、シンプールの名前に置き換えます。

検証

data_percentセグメントが拡張されたことを確認します。# lvs -o lv_name,seg_type,data_percent LV Type Data% ThinPoolName thin-pool 40.23

関連情報

-

lvs(8)、lvextend(8)man ページ -

lvs -o help

4.3.3.1.3. シンプールのメタデータセグメントの拡張

lvextend コマンドを使用して、metadata_percent セグメントを拡張できます。

前提条件

- 管理アクセスがある。

手順

metadata_percentセグメントを表示します。# lvs -o lv_name,seg_type,metadata_percent LV Type Meta% ThinPoolName thin-pool 75.00metadata_percentセグメントを拡張します。# lvextend -L Size VolumeGroupName/ThinPoolName_tmetaSize は、メタデータセグメントのサイズに置き換えます。VolumeGroupName は、ボリュームグループの名前に置き換えます。ThinPoolName は、シンプールの名前に置き換えます。

検証

metadata_percentセグメントが拡張されたことを確認します。# lvs -o lv_name,seg_type,metadata_percent LV Type Meta% ThinPoolName thin-pool 0.19

関連情報

-

lvs(8)、lvextend(8)man ページ -

lvs -o help

4.3.3.2. シンプールの自動拡張

監視を有効にして、thin_pool_autoextend_threshold および thin_pool_autoextend_percent 設定パラメーターを設定することで、シンプールの拡張を自動化できます。

前提条件

- 管理アクセスがある。

手順

シンプールが監視されているかどうかを確認します。

# lvs -o lv_name,vg_name,seg_monitor LV VG Monitor ThinPoolName VolumeGroupName not monitoreddmeventdデーモンを使用してシンプールの監視を有効にします。# lvchange --monitor y VolumeGroupName/ThinPoolNameVolumeGroupName は、ボリュームグループの名前に置き換えます。ThinPoolName は、シンプールの名前に置き換えます。

-

rootユーザーとして、任意のエディターで/etc/lvm/lvm.confファイルを開きます。 thin_pool_autoextend_threshold行とthin_pool_autoextend_percent行のコメントを解除し、各パラメーターを必要な値に設定します。thin_pool_autoextend_threshold = 70 thin_pool_autoextend_percent = 20

thin_pool_autoextend_thresholdは、LVM がシンプールの自動拡張を開始するパーセンテージを指定します。たとえば、これを 70 に設定すると、容量の 70% に達したときに LVM がシンプールの拡張を試みます。thin_pool_autoextend_percentは、しきい値に達したときにシンプールを何パーセント拡張するかを指定します。たとえば、これを 20 に設定すると、シンプールのサイズが現在のサイズの 20% 増加します。- 変更を保存し、エディターを終了します。

lvm2-monitorを再起動します。# systemctl restart lvm2-monitor

関連情報

-

lvs(8)、lvchange(8)、dmeventd(8)man ページ

4.3.4. 論理ボリュームの縮小

LV のサイズを縮小すると、解放された論理エクステントがボリュームグループに戻され、他の LV で使用できるようになります。

縮小される領域に保存されているデータが失われます。続行する前に必ずデータをバックアップし、ファイルシステムのサイズを変更してください。

前提条件

- 管理アクセスがある。

手順

論理ボリュームとそのボリュームグループをリスト表示します。

# lvs -o lv_name,vg_name,lv_size LV VG LSize LogicalVolumeName VolumeGroupName 6.49g論理ボリュームがマウントされている場所を確認します。

# findmnt -o SOURCE,TARGET /dev/VolumeGroupName/LogicalVolumeName SOURCE TARGET /dev/mapper/VolumeGroupName-NewLogicalVolumeName /MountPoint/dev/VolumeGroupName/LogicalVolumeName は、論理ボリュームへのパスに置き換えます。

論理ボリュームをアンマウントします。

# umount /MountPoint/MountPoint は、論理ボリュームのマウントポイントに置き換えます。

ファイルシステムエラーをチェックして修復します。

# e2fsck -f /dev/VolumeGroupName/LogicalVolumeNameLV とファイルシステムのサイズを変更します。

# lvreduce --size TargetSize --resizefs VolumeGroupName/LogicalVolumeNameTargetSize は、LV の新しいサイズに置き換えます。VolumeGroupName/LogicalVolumeName は、論理ボリュームへのパスに置き換えます。

ファイルシステムを再マウントします。

# mount -o remount /MountPoint/MountPoint は、ファイルシステムのマウントポイントに置き換えます。

検証

ファイルシステムの領域使用率を確認します。

# df -hT /MountPoint/ Filesystem Type Size Used Avail Use% Mounted on /dev/mapper/VolumeGroupName-NewLogicalVolumeName ext4 2.9G 139K 2.7G 1% /MountPoint/MountPoint は、論理ボリュームのマウントポイントに置き換えます。

LV のサイズを確認します。

# lvs -o lv_name,lv_size LV LSize NewLogicalVolumeName 4.00g

4.4. 論理ボリュームの名前変更

lvrename コマンドを使用して、スナップショットを含む既存の論理ボリュームの名前を変更できます。

前提条件

- 管理アクセスがある。

手順

論理ボリュームとそのボリュームグループをリスト表示します。

# lvs -o lv_name,vg_name LV VG LogicalVolumeName VolumeGroupName論理ボリュームの名前を変更します。

# lvrename VolumeGroupName/LogicalVolumeName VolumeGroupName/NewLogicalVolumeNameVolumeGroupName は、ボリュームグループの名前に置き換えます。LogicalVolumeName は、論理ボリュームの名前に置き換えます。NewLogicalVolumeName は、新しい論理ボリューム名に置き換えます。

検証

論理ボリュームの名前が変更されたことを確認します。

# lvs -o lv_name LV NewLogicalVolumeName

関連情報

-

システム上の

lvrename(8)man ページ

4.5. 論理ボリュームの削除

lvremove コマンドを使用して、スナップショットを含む既存の論理ボリュームを削除できます。

前提条件

- 管理アクセスがある。

手順

論理ボリュームとそのパスをリスト表示します。

# lvs -o lv_name,lv_path LV Path LogicalVolumeName /dev/VolumeGroupName/LogicalVolumeName論理ボリュームがマウントされている場所を確認します。

# findmnt -o SOURCE,TARGET /dev/VolumeGroupName/LogicalVolumeName SOURCE TARGET /dev/mapper/VolumeGroupName-LogicalVolumeName /MountPoint/dev/VolumeGroupName/LogicalVolumeName は、論理ボリュームへのパスに置き換えます。

論理ボリュームをアンマウントします。

# umount /MountPoint/MountPoint は、論理ボリュームのマウントポイントに置き換えます。

論理ボリュームを削除します。

# lvremove VolumeGroupName/LogicalVolumeNameVolumeGroupName/LogicalVolumeName は、論理ボリュームへのパスに置き換えます。

関連情報

-

システム上の

lvs(8)、lvremove(8)man ページ

4.6. 論理ボリュームのアクティブ化

lvchange コマンドを使用して論理ボリュームをアクティブ化できます。

前提条件

- 管理アクセスがある。

手順

論理ボリューム、そのボリュームグループ、およびパスをリスト表示します。

# lvs -o lv_name,vg_name,lv_path LV VG Path LogicalVolumeName VolumeGroupName VolumeGroupName/LogicalVolumeName論理ボリュームをアクティブ化します。

# lvchange --activate y VolumeGroupName/LogicalVolumeNameVolumeGroupName は、ボリュームグループの名前に置き換えます。LogicalVolumeName は、論理ボリュームの名前に置き換えます。

注記別の LV のスナップショットとして作成されたシン LV をアクティブ化する場合は、

--ignoreactivationskipオプションを使用してアクティブ化する必要がある場合があります。

検証

LV がアクティブであることを確認します。

# lvdisplay VolumeGroupName/LogicalVolumeName ... LV Status availableVolumeGroupName は、ボリュームグループの名前に置き換えます。LogicalVolumeName は、論理ボリュームの名前に置き換えます。

関連情報

-

lvs(8)lvchange(8)、lvdisplay(8)man ページ

4.7. 論理ボリュームの非アクティブ化

デフォルトでは、論理ボリュームを作成すると、アクティブ状態になります。lvchange コマンドを使用して論理ボリュームを非アクティブ化できます。

アクティブなマウントがある論理ボリュームや使用中の論理ボリュームを非アクティブ化すると、データの不整合やシステムエラーが発生する可能性があります。

前提条件

- 管理アクセスがある。

手順

論理ボリューム、そのボリュームグループ、およびパスをリスト表示します。

# lvs -o lv_name,vg_name,lv_path LV VG Path LogicalVolumeName VolumeGroupName /dev/VolumeGroupName/LogicalVolumeName論理ボリュームがマウントされている場所を確認します。

# findmnt -o SOURCE,TARGET /dev/VolumeGroupName/LogicalVolumeName SOURCE TARGET /dev/mapper/VolumeGroupName-LogicalVolumeName /MountPoint/dev/VolumeGroupName/LogicalVolumeName は、論理ボリュームへのパスに置き換えます。

論理ボリュームをアンマウントします。

# umount /MountPoint/MountPoint は、論理ボリュームのマウントポイントに置き換えます。

論理ボリュームを非アクティブにします。

# lvchange --activate n VolumeGroupName/LogicalVolumeNameVolumeGroupName は、ボリュームグループの名前に置き換えます。LogicalVolumeName は、論理ボリュームの名前に置き換えます。

検証

LV がアクティブでないことを確認します。

# lvdisplay VolumeGroupName/LogicalVolumeName ... LV Status NOT availableVolumeGroupName は、ボリュームグループの名前に置き換えます。LogicalVolumeName は、論理ボリュームの名前に置き換えます。

関連情報

-

lvs(8)lvchange(8)、lvdisplay(8)man ページ

第5章 高度な論理ボリューム管理

LVM には次のような高度な機能があります。

- スナップショット。スナップショットは論理ボリューム (LV) の特定時点のコピーです。

- キャッシュ。使用すると、高速なストレージを低速なストレージのキャッシュとして利用できるようになります。

- カスタムシンプールの作成

5.1. 論理ボリュームのスナップショットの管理

スナップショットは、特定時点における別の LV の内容をミラーリングする論理ボリューム (LV) です。

5.1.1. 論理ボリュームスナップショットにてういて

スナップショットを作成すると、特定時点における別の LV のコピーとして機能する新しい LV が作成されます。スナップショット LV は、最初は実際のデータを含んでいません。代わりに、スナップショット作成時における元の LV のデータブロックを参照します。

スナップショットのストレージ使用率を定期的に監視することが重要です。スナップショットに割り当てられている領域の 100% に達すると、スナップショットが無効になります。

スナップショットが完全にいっぱいになる前に拡張することが重要です。これは、lvextend コマンドを使用して手動で行うことも、/etc/lvm/lvm.conf ファイルを使用して自動的に行うこともできます。

- シック LV スナップショット

- 元の LV のデータが変更されると、コピーオンライト (CoW) システムによって、変更前の元のデータがスナップショットにコピーされます。この方法では、変更が発生した場合にのみスナップショットのサイズが増加し、スナップショット作成時における元のボリュームの状態が保存されます。シックスナップショットは、事前に一定量のストレージ領域を割り当てる必要がある LV の一種です。この量は後で増減できますが、元の LV にどのような変更を加える予定かを検討してください。そうすることで、割り当てる領域が多すぎるためにリソースが無駄になったり、割り当てる領域が少なすぎるためにスナップショットのサイズを頻繁に増やす必要が生じたりすることがなくなります。

- シン LV スナップショット

シンスナップショットは、既存のシンプロビジョニングされた LV から作成される LV の一種です。シンスナップショットでは、事前に追加の領域を割り当てる必要はありません。最初は、元の LV とそのスナップショットの両方が同じデータブロックを共有します。元の LV に変更が加えられると、新しいデータが別のブロックに書き込まれますが、スナップショットは元のブロックを参照し続け、スナップショット作成時における LV データの特定時点のビューが保持されます。

シンプロビジョニングは、必要に応じてディスク領域を割り当てることで、ストレージを効率的に最適化および管理する方法です。そのため、各 LV に事前に大量のストレージを割り当てる必要がなく、複数の LV を作成できます。ストレージがシンプール内のすべての LV で共有されるため、リソースをより効率的に使用できます。シンプールは、必要に応じて LV に領域を割り当てます。

- シック LV スナップショットとシン LV スナップショットの選択

- シック LV スナップショットとシン LV スナップショットの選択は、スナップショットの作成元とする LV のタイプによって直接決まります。元の LV がシック LV である場合、スナップショットもシックになります。元の LV がシン LV の場合は、スナップショットもシンになります。

5.1.2. シック論理ボリュームスナップショットの管理

シック LV スナップショットを作成するときは、ストレージ要件とスナップショットの想定される有効期間を考慮することが重要です。元のボリュームに予想される変更に基づいて、十分なストレージを割り当てる必要があります。スナップショットは、想定される有効期間中の変更を取り込むのに十分なサイズである必要がありますが、元の LV のサイズを超えることはできません。変更頻度が低いと予想される場合は、10% - 15% の小さいスナップショットサイズで十分な場合があります。変更頻度が高い LV の場合は、30% 以上を割り当てる必要がある場合があります。

スナップショットが完全にいっぱいになる前に拡張することが重要です。スナップショットに割り当てられている領域の 100% に達すると、スナップショットが無効になります。lvs -o lv_name,data_percent,origin コマンドを使用すると、スナップショットの容量を監視できます。

5.1.2.1. シック論理ボリュームスナップショットの作成

lvcreate コマンドを使用して、シック LV スナップショットを作成できます。

前提条件

- 管理アクセスがある。

- 物理ボリュームが作成されている。詳細は、LVM 物理ボリュームの作成 を参照してください。

- ボリュームグループが作成されている。詳細は、LVM ボリュームグループの作成 を参照してください。

- 論理ボリュームが作成されている。詳細は、論理ボリュームの作成 を参照してください。

手順

スナップショットを作成する LV を特定します。

# lvs -o vg_name,lv_name,lv_size VG LV LSize VolumeGroupName LogicalVolumeName 10.00gスナップショットのサイズは LV のサイズを超えることはできません。

シック LV スナップショットを作成します。

# lvcreate --snapshot --size SnapshotSize --name SnapshotName VolumeGroupName/LogicalVolumeNameSnapshotSize は、スナップショットに割り当てるサイズ (例: 10 G) に置き換えます。SnapshotName は、スナップショット論理ボリュームに付ける名前に置き換えます。VolumeGroupName は、元の論理ボリュームを含むボリュームグループの名前に置き換えます。LogicalVolumeName は、スナップショットの作成元とする論理ボリュームの名前に置き換えます。

検証

スナップショットが作成されたことを確認します。

# lvs -o lv_name,origin LV Origin LogicalVolumeName SnapshotName LogicalVolumeName

関連情報

-

lvcreate(8)およびlvs(8)man ページ

5.1.2.2. 論理ボリュームスナップショットの手動拡張

スナップショットに割り当てられている領域の 100% に達すると、スナップショットが無効になります。スナップショットが完全にいっぱいになる前に拡張することが重要です。これは、lvextend コマンドを使用して手動で実行できます。

前提条件

- 管理アクセスがある。

手順

ボリュームグループ、論理ボリューム、スナップショットのソースボリュームの名前、使用率、およびサイズをリスト表示します。

# lvs -o vg_name,lv_name,origin,data_percent,lv_size VG LV Origin Data% LSize VolumeGroupName LogicalVolumeName 10.00g VolumeGroupName SnapshotName LogicalVolumeName 82.00 5.00gシックプロビジョニングされたスナップショットを拡張します。

# lvextend --size +AdditionalSize VolumeGroupName/SnapshotNameAdditionalSize は、スナップショットに追加する容量 (例: +1G) に置き換えます。VolumeGroupName は、ボリュームグループの名前に置き換えます。SnapshotName は、スナップショットの名前に置き換えます。

検証

LV が拡張されたことを確認します。

# lvs -o vg_name,lv_name,origin,data_percent,lv_size VG LV Origin Data% LSize VolumeGroupName LogicalVolumeName 10.00g VolumeGroupName SnapshotName LogicalVolumeName 68.33 6.00g

5.1.2.3. シック論理ボリュームスナップショットの自動拡張

スナップショットに割り当てられている領域の 100% に達すると、スナップショットが無効になります。スナップショットが完全にいっぱいになる前に拡張することが重要です。これは自動的に実行できます。

前提条件

- 管理アクセスがある。

手順

-

rootユーザーとして、任意のエディターで/etc/lvm/lvm.confファイルを開きます。 snapshot_autoextend_threshold行とsnapshot_autoextend_percent行のコメントを解除し、各パラメーターを必要な値に設定します。snapshot_autoextend_threshold = 70 snapshot_autoextend_percent = 20

snapshot_autoextend_thresholdは、LVM がスナップショットの自動拡張を開始するパーセンテージを指定します。たとえば、このパラメーターを 70 に設定すると、容量の 70% に達したときに LVM がスナップショットの拡張を試みます。snapshot_autoextend_percentは、しきい値に達したときにスナップショットを何パーセント拡張するかを指定します。たとえば、パラメーターを 20 に設定すると、スナップショットが現在のサイズの 20% 増加します。- 変更を保存し、エディターを終了します。

lvm2-monitorを再起動します。# systemctl restart lvm2-monitor

5.1.2.4. シック論理ボリュームのスナップショットのマージ

シック LV スナップショットを、スナップショットの作成元となった元の論理ボリュームにマージできます。マージプロセスでは、元の LV がスナップショット作成時点の状態に戻されます。マージが完了すると、スナップショットは削除されます。

元の LV とスナップショット LV 間のマージは、どちらかがアクティブな場合、延期されます。両方の LV が再アクティブ化され、使用されていない場合にのみ続行されます。

前提条件

- 管理アクセスがある。

手順

LV、そのボリュームグループ、およびそのパスをリスト表示します。

# lvs -o lv_name,vg_name,lv_path LV VG Path LogicalVolumeName VolumeGroupName /dev/VolumeGroupName/LogicalVolumeName SnapshotName VolumeGroupName /dev/VolumeGroupName/SnapshotNameLV がマウントされている場所を確認します。

# findmnt -o SOURCE,TARGET /dev/VolumeGroupName/LogicalVolumeName # findmnt -o SOURCE,TARGET /dev/VolumeGroupName/SnapshotName

/dev/VolumeGroupName/LogicalVolumeName は、論理ボリュームへのパスに置き換えます。/dev/VolumeGroupName/SnapshotName は、スナップショットへのパスに置き換えます。

LV をアンマウントします。

# umount /LogicalVolume/MountPoint # umount /Snapshot/MountPoint

/LogicalVolume/MountPoint は、論理ボリュームのマウントポイントに置き換えます。/Snapshot/MountPoint は、スナップショットのマウントポイントに置き換えます。

LV を非アクティブ化します。

# lvchange --activate n VolumeGroupName/LogicalVolumeName # lvchange --activate n VolumeGroupName/SnapshotName

VolumeGroupName は、ボリュームグループの名前に置き換えます。LogicalVolumeName は、論理ボリュームの名前に置き換えます。SnapshotName は、スナップショットの名前に置き換えます。

シック LV スナップショットを元の LV にマージします。

# lvconvert --merge SnapshotNameSnapshotName は、スナップショットの名前に置き換えます。

LV をアクティブ化します。

# lvchange --activate y VolumeGroupName/LogicalVolumeNameVolumeGroupName は、ボリュームグループの名前に置き換えます。LogicalVolumeName は、論理ボリュームの名前に置き換えます。

LV をマウントします。

# umount /LogicalVolume/MountPoint/LogicalVolume/MountPoint は、論理ボリュームのマウントポイントに置き換えます。

検証

スナップショットが削除されたことを確認します。

# lvs -o lv_name

関連情報

-

lvconvert(8)、lvs(8)man ページ

5.1.3. シン論理ボリュームスナップショットの管理

ストレージ効率を優先する場合は、シンプロビジョニングが適しています。ストレージ領域の動的割り当てにより、初期のストレージコストが削減され、利用可能なストレージリソースが最大限に使用されます。動的なワークロードがある環境や、時間の経過とともにストレージが増加する環境では、シンプロビジョニングによって柔軟性が向上します。これにより、ストレージ領域を事前に大量に割り当てることなく、ストレージシステムをニーズの変化に適応させることができます。動的な割り当てにより、オーバープロビジョニングが可能になります。つまり、すべての LV の合計サイズが、シンプールの物理サイズを超えることがあります。これは、すべての領域が同時に使用されるわけではないということを前提にしているためです。

5.1.3.1. シン論理ボリュームスナップショットの作成

lvcreate コマンドを使用して、シン LV スナップショットを作成できます。シン LV スナップショットを作成するときは、スナップショットサイズを指定しないでください。サイズのパラメーターを含めると、代わりにシックスナップショットが作成されます。

前提条件

- 管理アクセスがある。

- 物理ボリュームが作成されている。詳細は、LVM 物理ボリュームの作成 を参照してください。

- ボリュームグループが作成されている。詳細は、LVM ボリュームグループの作成 を参照してください。

- 論理ボリュームが作成されている。詳細は、論理ボリュームの作成 を参照してください。

手順

スナップショットを作成する LV を特定します。

# lvs -o lv_name,vg_name,pool_lv,lv_size LV VG Pool LSize PoolName VolumeGroupName 152.00m ThinVolumeName VolumeGroupName PoolName 100.00mシン LV スナップショットを作成します。

# lvcreate --snapshot --name SnapshotName VolumeGroupName/ThinVolumeNameSnapshotName は、スナップショット論理ボリュームに付ける名前に置き換えます。VolumeGroupName は、元の論理ボリュームを含むボリュームグループの名前に置き換えます。ThinVolumeName は、スナップショットの作成元とするシン論理ボリュームの名前に置き換えます。

検証

スナップショットが作成されたことを確認します。

# lvs -o lv_name,origin LV Origin PoolName SnapshotName ThinVolumeName ThinVolumeName

関連情報

-

lvcreate(8)およびlvs(8)man ページ

5.1.3.2. シン論理ボリュームスナップショットのマージ

シン LV スナップショットを、スナップショットの作成元となった元の論理ボリュームにマージできます。マージプロセスでは、元の LV がスナップショット作成時点の状態に戻されます。マージが完了すると、スナップショットは削除されます。

前提条件

- 管理アクセスがある。

手順

LV、そのボリュームグループ、およびそのパスをリスト表示します。

# lvs -o lv_name,vg_name,lv_path LV VG Path ThinPoolName VolumeGroupName ThinSnapshotName VolumeGroupName /dev/VolumeGroupName/ThinSnapshotName ThinVolumeName VolumeGroupName /dev/VolumeGroupName/ThinVolumeName元の LV がマウントされている場所を確認します。

# findmnt -o SOURCE,TARGET /dev/VolumeGroupName/ThinVolumeNameVolumeGroupName/ThinVolumeName は、論理ボリュームへのパスに置き換えます。

LV をアンマウントします。

# umount /ThinLogicalVolume/MountPoint/ThinLogicalVolume/MountPoint は、論理ボリュームのマウントポイントに置き換えます。/ThinSnapshot/MountPoint は、スナップショットのマウントポイントに置き換えます。

LV を非アクティブ化します。

# lvchange --activate n VolumeGroupName/ThinLogicalVolumeNameVolumeGroupName は、ボリュームグループの名前に置き換えます。ThinLogicalVolumeName は、論理ボリュームの名前に置き換えます。

シン LV スナップショットを元の LV にマージします。

# lvconvert --mergethin VolumeGroupName/ThinSnapshotNameVolumeGroupName は、ボリュームグループの名前に置き換えます。ThinSnapshotName は、スナップショットの名前に置き換えます。

LV をマウントします。

# umount /ThinLogicalVolume/MountPoint/ThinLogicalVolume/MountPoint は、論理ボリュームのマウントポイントに置き換えます。

検証

元の LV がマージされたことを確認します。

# lvs -o lv_name

関連情報

-

lvremove(8)、lvs(8)man ページ

5.2. 論理ボリュームのキャッシュ

dm-cache または dm-writecache ターゲットを使用して論理ボリュームをキャッシュできます。

dm-cache は、高速なストレージデバイス (SSD) を、低速なストレージデバイス (HDD) のキャッシュとして利用します。読み取りおよび書き込みデータをキャッシュし、頻繁に使用されるデータへのアクセス時間を最適化します。読み取り操作と書き込み操作を強化することでパフォーマンスが大幅に向上する混合ワークロード環境で役立ちます。

dm-writecache は、書き込みデータがプライマリーストレージデバイス (HDD) にコミットされる前に、高速なストレージメディア (SSD) を使用して一時的に書き込みデータを保持することで、書き込み操作を最適化します。書き込みのパフォーマンスによってデータ転送プロセスが遅くなる可能性がある、書き込みが多いアプリケーションに役立ちます。

5.2.1. dm-cache による論理ボリュームのキャッシュ

dm-cache を使用して LV をキャッシュすると、キャッシュプールが作成されます。キャッシュプールは、キャッシュされた実際の内容を保存するキャッシュデータと、キャッシュに保存された内容を追跡するキャッシュメタデータを組み合わせた LV です。このプールは、データをキャッシュするために特定の LV に関連付けられます。

dm-cache は、2 種類のブロックを対象とします。頻繁にアクセスされる (ホット) ブロックは、キャッシュに移動されます。あまり頻繁にアクセスされない (コールド) ブロックは、低速のデバイスに残ります。

前提条件

- 管理アクセスがある。

手順

キャッシュする LV とそのボリュームグループを表示します。

# lvs -o lv_name,vg_name LV VG LogicalVolumeName VolumeGroupNameキャッシュプールを作成します。

# lvcreate --type cache-pool --name CachePoolName --size Size VolumeGroupName /FastDevicePathCachePoolName は、キャッシュプールの名前に置き換えます。Size は、キャッシュプールのサイズに置き換えます。VolumeGroupName は、ボリュームグループの名前に置き換えます。/FastDevicePath は、SSD や NVME などの高速デバイスへのパスに置き換えます。

キャッシュプールを LV にアタッチします。

# lvconvert --type cache --cachepool VolumeGroupName/CachePoolName VolumeGroupName/LogicalVolumeName

検証

LV がキャッシュされたことを確認します。

# lvs -o lv_name,pool_lv LV Pool LogicalVolumeName [CachePoolName_cpool]

関連情報

-

lvcreate(8)、lvconvert(8)、lvs(8)man ページ

5.2.2. dm-writecache による論理ボリュームのキャッシュ

dm-writecache を使用して LV をキャッシュすると、論理ボリュームと物理ストレージデバイスの間にキャッシュレイヤーが作成されます。dm-writecache は、書き込み操作を SSD などの高速ストレージメディアに一時的に保存し、最終的にプライマリーストレージデバイスに書き戻すことで、書き込み集中型のワークロードを最適化します。

前提条件

- 管理アクセスがある。

手順

キャッシュする論理ボリュームとそのボリュームグループを表示します。

# lvs -o lv_name,vg_name LV VG LogicalVolumeName VolumeGroupNameキャッシュボリュームを作成します。

# lvcreate --name CacheVolumeName --size Size VolumeGroupName /FastDevicePathCacheVolumeName は、キャッシュボリュームの名前に置き換えます。Size は、キャッシュプールのサイズに置き換えます。VolumeGroupName は、ボリュームグループの名前に置き換えます。/FastDevicePath は、SSD や NVME などの高速デバイスへのパスに置き換えます。

キャッシュボリュームを LV にアタッチします。

# lvconvert --type writecache --cachevol CacheVolumeName VolumeGroupName/LogicalVolumeNameCacheVolumeName は、キャッシュボリュームの名前に置き換えます。VolumeGroupName は、ボリュームグループの名前に置き換えます。LogicalVolumeName は、論理ボリュームの名前に置き換えます。

検証

LV がキャッシュされたことを確認します。

# lvs -o lv_name,pool_lv LV Pool LogicalVolumeName [CacheVolumeName_cvol]

関連情報

-

lvcreate(8)、lvconvert(8)、lvs(8)man ページ

5.2.3. 論理ボリュームのキャッシュ削除

LV からキャッシュを削除するには、主に 2 つの方法を使用します。

- 分割

- キャッシュボリューム自体を保持しながら、キャッシュを LV からデタッチできます。この場合、LV はキャッシュメカニズムの恩恵を受けられなくなりますが、キャッシュボリュームとそのデータはそのまま残ります。キャッシュボリュームは保持されますが、キャッシュ内のデータは再利用できず、次回キャッシュ設定で使用されるときに消去されます。

- キャッシュ削除

- キャッシュを LV からデタッチし、さらにキャッシュボリュームを完全に削除できます。この操作により、キャッシュが効果的に破棄され、領域が解放されます。

前提条件

- 管理アクセスがある。

手順

キャッシュされた LV を表示します。

# lvs -o lv_name,pool_lv,vg_name LV Pool VG LogicalVolumeName [CacheVolumeName_cvol] VolumeGroupNameキャッシュされたボリュームをデタッチまたは削除します。

キャッシュされたボリュームをデタッチするには、次のコマンドを使用します。

# lvconvert --splitcache VolumeGroupName/LogicalVolumeNameキャッシュされたボリュームをデタッチして削除するには、次のコマンドを使用します。

# lvconvert --uncache VolumeGroupName/LogicalVolumeNameVolumeGroupName は、ボリュームグループの名前に置き換えます。LogicalVolumeName は、論理ボリュームの名前に置き換えます。

検証

LV がキャッシュされていないことを確認します。

# lvs -o lv_name,pool_lv

関連情報

-

lvconvert(8)、lvs(8)man ページ

5.3. カスタムシンプールの作成

ストレージをより適切に制御するために、カスタムシンプールを作成できます。

前提条件

- 管理アクセスがある。

手順

利用可能なボリュームグループを表示します。

# vgs -o vg_name VG VolumeGroupName利用可能なデバイスをリスト表示します。

# lsblkシンプールのデータを保持する LV を作成します。

# lvcreate --name ThinPoolDataName --size Size VolumeGroupName /DevicePathThinPoolDataName は、シンプールデータ用の LV の名前に置き換えます。Size は、LV のサイズに置き換えます。VolumeGroupName は、ボリュームグループの名前に置き換えます。

シンプールのメタデータを保持する LV を作成します。

# lvcreate --name ThinPoolMetadataName --size Size VolumeGroupName /DevicePathLV をシンプールにマージします。

# lvconvert --type thin-pool --poolmetadata ThinPoolMetadataName VolumeGroupName/ThinPoolDataName

検証

カスタムシンプールが作成されたことを確認します。

# lvs -o lv_name,seg_type LV Type ThinPoolDataName thin-pool

関連情報

-

vgs(8)lvs(8)、lvcreate(8)man ページ

第6章 スナップショットを使用したシステムアップグレードの管理

Red Hat Enterprise Linux システムのロールバック可能なアップグレードを実行して、以前のバージョンのオペレーティングシステムに戻します。Boom Boot Manager と Leapp オペレーティングシステム最新化フレームワークを使用できます。

オペレーティングシステムのアップグレードを実行する前に、次の点を考慮してください。

-

スナップショットを使用したシステムアップグレードは、システムツリー内の複数のファイルシステム (別の

/varパーティションや/usrパーティションなど) では機能しません。 - スナップショットを使用したシステムのアップグレードは、Red Hat Update Infrastructure (RHUI) システムでは機能しません。Boom ユーティリティーを使用する代わりに、仮想マシン (VM) のスナップショットを作成することを検討してください。

6.1. Boom プロセスの概要

Boom Boot Manager を使用してブートエントリーを作成すると、GRUB ブートローダーメニューからこれらのエントリーを選択してアクセスできるようになります。ブートエントリーを作成すると、ロールバック可能なアップグレードの準備プロセスが簡素化されます。

次のブートエントリーは、アップグレードおよびロールバックプロセスの一部です。

ブートエントリーのアップグレードLeapp アップグレード環境を起動します。

leappユーティリティーを使用して、このブートエントリーを作成および管理します。Leappアップグレードプロセスでは、このエントリーは自動的に削除されます。Red Hat Enterprise Linux 8 boot entryアップグレードシステム環境を起動します。アップグレードプロセスが正常に完了したら、

leappユーティリティーを使用してこのブートエントリーを作成します。スナップショットのブートエントリー元のシステムのスナップショットを起動します。これを使用して、アップグレードの成功後または失敗後に、以前のオペレーティングシステムの状態を確認およびテストします。オペレーティングシステムをアップグレードする前に、

boomコマンドを使用してこのブートエントリーを作成します。ロールバックのブートエントリーアップグレード前のシステムの環境で起動し、アップグレードが行われている部分を以前のシステムの状態にロールバックします。アップグレード手順のロールバックを開始するときに、

boomコマンドを使用してこのブートエントリーを作成します。

関連情報

-

システム上の

boom(1)man ページ

6.2. Boom Boot Manager を使用した別のバージョンへのアップグレード

Boom Boot Manager を使用して、Red Hat Enterprise Linux オペレーティングシステムのアップグレードを実行します。

前提条件

- Red Hat Enterprise Linux 8.8 または 8.10 が実行されている。

-

lvm2-Python-boomパッケージの現在のバージョン (バージョン lvm2-Python-boom-1.2-2.el7_9.5 以降) がインストールされています。 - スナップショットに使用できる十分な領域がある。元のインストールのサイズに基づいてサイズを推定します。マウントされているすべての論理ボリュームをリストします。

-

leappパッケージがインストールされている。 - ソフトウェアリポジトリーが有効になっている。

追加のファイルシステムとして、/usr または /var が含まれている場合があります。

手順

root 論理ボリュームのスナップショットを作成します。

root ファイルシステムがシンプロビジョニングを使用する場合は、シンスナップショットを作成します。

# lvcreate -s rhel/root -kn -n root_snapshot_before_changes Logical volume "root_snapshot_before_changes" created.

ここでは、以下のようになります。

-

-sはスナップショットを作成します。 -

rhel/rootはファイルシステムを論理ボリュームにコピーします。 -

-knはブート時に LV を自動的にアクティブ化します。 -n root_snapshot_before_changesはスナップショットの名前を示します。シンスナップショットを作成している間は、スナップショットのサイズを定義することができません。スナップショットは、シンプールから割り当てられます。

-

root ファイルシステムがシックプロビジョニングを使用する場合は、シックスナップショットを作成します。

# lvcreate -s rhel/root -n root_snapshot_before_changes -L 25g Logical volume "root_snapshot_before_changes" created.このコマンドでは、以下が行われます。

-

-sはスナップショットを作成します。 -

rhel/rootはファイルシステムを論理ボリュームにコピーします。 -

-n root_snapshot_before_changesはスナップショットの名前を示します。 -L 25gはスナップショットのサイズです。元のインストールのサイズに基づいてサイズを推定します。シックスナップショットを作成する際は、アップグレード中にすべての変更を保持できるスナップショットサイズを定義します。

重要作成されたスナップショットには、追加のシステム変更は含まれません。

-

GRUB ブートローダーを使用して

boom を有効にする# grub2-mkconfig > /boot/grub2/grub.cfg Generating grub configuration file ... Found linux image: /boot/vmlinuz-3.10.0-1160.118.1.el7.x86_64 Found initrd image: /boot/initramfs-3.10.0-1160.118.1.el7.x86_64.img Found linux image: /boot/vmlinuz-3.10.0-1160.el7.x86_64 Found initrd image: /boot/initramfs-3.10.0-1160.el7.x86_64.img Found linux image: /boot/vmlinuz-0-rescue-f9f6209866c743739757658d1a4850b2 Found initrd image: /boot/initramfs-0-rescue-f9f6209866c743739757658d1a4850b2.img doneプロファイルを作成します。

# boom profile create --from-host --uname-pattern el7 Created profile with os_id f150f3d: OS ID: "f150f3d6693495254255d46e20ecf5c690ec3262", Name: "Red Hat Enterprise Linux Server", Short name: "rhel", Version: "7.9 (Maipo)", Version ID: "7.9", Kernel pattern: "/vmlinuz-%{version}", Initramfs pattern: "/initramfs-%{version}.img", Root options (LVM2): "rd.lvm.lv=%{lvm_root_lv}", Root options (BTRFS): "rootflags=%{btrfs_subvolume}", Options: "root=%{root_device} ro %{root_opts}", Title: "%{os_name} %{os_version_id} (%{version})", Optional keys: "grub_users grub_arg grub_class id", UTS release pattern: "el7"元のブートイメージのバックアップコピーを使用して、元のシステムのスナップショットブートエントリーを作成します。

# boom create --backup --title "Root LV snapshot before changes" --rootlv rhel/root_snapshot_before_changes Created entry with boot_id bfef767: title Root LV snapshot before changes machine-id 7d70d7fcc6884be19987956d0897da31 version 3.10.0-1160.114.2.el7.x86_64 linux /vmlinuz-3.10.0-1160.114.2.el7.x86_64.boom0 initrd /initramfs-3.10.0-1160.114.2.el7.x86_64.img.boom0 options root=/dev/rhel/root_snapshot_before_changes ro rd.lvm.lv=rhel/root_snapshot_before_changes grub_users $grub_users grub_arg --unrestricted grub_class kernel

ここでは、以下のようになります。

-

--title "Root LV snapshot before changes"は、システム起動時にブートエントリーリストに表示されるブートエントリーの名前です。 --rootlvは、新しいブートエントリーに対応する root 論理ボリュームです。前の手順を完了すると、アップグレード前の元のシステムにアクセスできるブートエントリーが作成されます。

-

Leapp ユーティリティーを使用して Red Hat Enterprise Linux 8 にアップグレードします。

# leapp upgrade ==> Processing phase `configuration_phase` ====> * ipu_workflow_config IPU workflow config actor ==> Processing phase `FactsCollection` ... ============================================================ REPORT OVERVIEW ============================================================ Upgrade has been inhibited due to the following problems: 1. Btrfs has been removed from RHEL8 2. Missing required answers in the answer file HIGH and MEDIUM severity reports: 1. Packages available in excluded repositories will not be installed 2. GRUB core will be automatically updated during the upgrade 3. Difference in Python versions and support in RHEL 8 4. chrony using default configuration Reports summary: Errors: 0 Inhibitors: 2 HIGH severity reports: 3 MEDIUM severity reports: 1 LOW severity reports: 3 INFO severity reports: 4 Before continuing consult the full report: A report has been generated at /var/log/leapp/leapp-report.json A report has been generated at /var/log/leapp/leapp-report.txt ============================================================ END OF REPORT OVERVIEW ============================================================leapp upgradeコマンドのレポートで表示されたブロッカーを確認して解決します。レポートの詳細な手順については、コマンドラインからのアップグレード可能性の評価 を参照してください。アップグレードブートエントリーで再起動します。

# leapp upgrade --reboot ==> Processing phase `configuration_phase` ====> * ipu_workflow_config IPU workflow config actor ==> Processing phase `FactsCollection` ...GRUB ブート画面から Red Hat Enterprise Linux Upgrade Initramfs エントリーを選択します。

注記GRUB ブート画面の Snapshots サブメニューは、Red Hat Enterprise Linux 8 では使用できません。

検証

- アップグレードが完了すると、システムが自動的に再起動します。GRUB 画面に、使用可能なオペレーティングシステムのアップグレードされたバージョン (Red Hat Enterprise Linux 9) と以前のバージョンが表示されます。アップグレードされたシステムバージョンがデフォルトの選択です。

関連情報

-

システム上の

boom(1)man ページ - What is BOOM and how to install it?(Red Hat ナレッジベース)

- How to create a BOOM boot entry (Red Hat ナレッジベース)

- RHEL 7 から RHEL 8 へのインプレースアップグレード時に Leapp ユーティリティーで必要なデータ

6.3. Red Hat Enterprise Linux のバージョン間の切り替え

マシン上の Red Hat Enterprise Linux の最新バージョンと以前のバージョンに同時にアクセスします。Boom Boot Manager を使用してさまざまなオペレーティングシステムのバージョンにアクセスすると、オペレーティングシステムのアップグレードに伴うリスクが軽減され、ハードウェアのダウンタイムも削減されます。環境を切り替えるこの機能により、次のことが可能になります。

- サイドバイサイド方式で両環境をすばやく比較する。

- アップグレードの結果を評価しながら環境を切り替える。

- ファイルシステムの古いコンテンツを復元する。

- アップグレードしたホストの実行中も古いシステムへのアクセスを継続する。

- 更新自体が実行中でも、更新プロセスをいつでも中止して、元に戻す。

手順

システムを再起動します。

# reboot- GRUB ブートローダー画面から必要なブートエントリーを選択します。

検証

選択したブートボリュームが表示されていることを確認します。

# cat /proc/cmdline BOOT_IMAGE=(hd0,msdos1)/vmlinuz-3.10.0-1160.118.1.el7.x86_64.boom0 root=/dev/rhel/root_snapshot_before_changes ro rd.lvm.lv=rhel/root_snapshot_before_changes

関連情報

-

システム上の

boom(1)man ページ

6.4. アップグレードが成功した後に論理ボリュームのスナップショットを削除する

Boom Boot Manager を使用してシステムを正常にアップグレードしたら、スナップショットブートエントリーと論理ボリューム (LV) のスナップショットを削除して、アップグレードしたシステムを使用できます。

LV のスナップショットを削除すると、それ以上そのスナップショットの操作を実行できなくなります。

前提条件

- 最近、Boom Boot Manager を使用 して Red Hat Enterprise Linux を新しいバージョンにアップグレードした。

手順

- GRUB ブートローダー画面から Red Hat Enterprise Linux 9 を起動します。

システムがロードされたら、利用可能なブートエントリーを表示します。次の出力は、boom ブートエントリーのリストに含まれるスナップショットのブートエントリーを示しています。

# boom list WARNING - Options for BootEntry(boot_id=cae29bf) do not match OsProfile: marking read-only BootID Version Name RootDevice e0252ad 3.10.0-1160.118.1.el7.x86_64 Red Hat Enterprise Linux Server /dev/rhel/root_snapshot_before_changes 611ad14 3.10.0-1160.118.1.el7.x86_64 Red Hat Enterprise Linux Server /dev/mapper/rhel-root 3bfed71- 3.10.0-1160.el7.x86_64 Red Hat Enterprise Linux Server /dev/mapper/rhel-root _cae29bf 4.18.0-513.24.1.el8_9.x86_64 Red Hat Enterprise Linux /dev/mapper/rhel-root

警告は予想通りですが、これらのエントリーは

カーネルおよびgrubbyパッケージによって管理されるため、boom を使用して変更または削除することはできません。BootID値を使用してスナップショットのエントリーを削除します。# boom delete --boot-id e0252ad Deleted 1 entryこれにより、GRUB メニューからブートエントリーが削除されます。

論理ボリューム (LV) のスナップショットを削除します。

# lvremove rhel/root_snapshot_before_changes Do you really want to remove active logical volume rhel/root_snapshot_before_changes? [y/n]: y Logical volume "root_snapshot_before_changes" successfully removed

- アップグレード後の残りのタスクを完了します。詳細は、RHEL 7 から RHEL 8 へのアップグレード を参照してください。

関連情報

-

システム上の

boom(1)man ページ

6.5. アップグレードが失敗した後にロールバックブートエントリーを作成する

アップグレードが失敗した後にオペレーティングシステムのアップグレードをシステムの以前の状態に戻すには、ロールバックブートエントリーを使用します。これは、社内ソフトウェアとの非互換性など、アップグレードした環境に問題が見つかった場合にも役立ちます。

ロールバックブートエントリーを準備するには、スナップショット環境を使用します。

前提条件

- スナップショットがある。スナップショットを作成する手順については、Boom Boot Manager を使用した別のバージョンへのアップグレード を参照してください。

手順

スナップショットを元のボリュームとマージします。

# lvconvert --merge rhel/root_snapshot_before_changes Logical volume rhel/root_snapshot_before_changes contains a filesystem in use. Delaying merge since snapshot is open. Merging of thin snapshot rhel/root_snapshot_before_changes will occur on next activation of rhel/root.警告スナップショットをマージした後、データの損失を防ぐために、この手順の残りのすべてのステップを続けて実行する必要があります。

マージされたスナップショットのロールバックブートエントリーを作成します。

# boom create --backup --title "RHEL Rollback" --rootlv rhel/root Created entry with boot_id 1e6d298: title RHEL Rollback machine-id f9f6209866c743739757658d1a4850b2 version 3.10.0-1160.118.1.el7.x86_64 linux /vmlinuz-3.10.0-1160.118.1.el7.x86_64.boom0 initrd /initramfs-3.10.0-1160.118.1.el7.x86_64.img.boom0 options root=/dev/rhel/root ro rd.lvm.lv=rhel/root grub_users $grub_users grub_arg --unrestricted grub_class kernel

マシンを再起動して、オペレーティングシステムの状態を復元します。

# reboot- システムが再起動したら、GRUB 画面から RHEL Rollback ブートエントリーを選択します。

root論理ボリュームがアクティブになると、システムは自動的にスナップショットのマージ操作を開始します。重要マージ操作が開始されると、スナップショットボリュームは使用できなくなります。RHEL Rollback ブートエントリーが正常に起動すると、ルート LV スナップショットブートエントリー が機能しなくなります。スナップショットの論理ボリュームをマージすると、ルート LV スナップショットが破棄され、元のボリュームの以前の状態が復元されます。

マージ操作が完了したら、未使用のエントリーを削除し、元のブートエントリーを復元します。

未使用の Red Hat Enterprise Linux 8 ブートエントリーを

/bootファイルシステムから削除し、変更を有効にするためにgrub.cfgファイルを再構築します。# rm -f /boot/loader/entries/*.el8*# rm -f /boot/*.el8*# grub2-mkconfig -o /boot/grub2/grub.cfg Generating grub configuration file ... Found linux image: /boot/vmlinuz-3.10.0-1160.118.1.el7.x86_64.boom0 .... done元の Red Hat Enterprise Linux ブートエントリーを復元します。

# new-kernel-pkg --update $(uname -r)

システムへのロールバックが成功したら、

boomスナップショットを削除し、ブートエントリーをロールバックします。# boom list -o+title BootID Version Name RootDevice Title a49fb09 3.10.0-1160.118.1.el7.x86_64 Red Hat Enterprise Linux Server /dev/mapper/rhel-root Red Hat Enterprise Linux (3.10.0-1160.118.1.el7.x86_64) 8.9 (Ootpa) 1bb11e4 3.10.0-1160.el7.x86_64 Red Hat Enterprise Linux Server /dev/mapper/rhel-root Red Hat Enterprise Linux (3.10.0-1160.el7.x86_64) 8.9 (Ootpa) e0252ad 3.10.0-1160.118.1.el7.x86_64 Red Hat Enterprise Linux Server /dev/rhel/root_snapshot_before_changes Root LV snapshot before changes 1e6d298 3.10.0-1160.118.1.el7.x86_64 Red Hat Enterprise Linux Server /dev/rhel/root RHEL Rollback

# boom delete e0252ad Deleted 1 entry # boom delete 1e6d298 Deleted 1 entry

関連情報

-

システム上の

boom(1)man ページ

第7章 LVM レポートのカスタマイズ

LVM は、カスタマイズしたレポートを生成するための幅広い設定オプションとコマンドラインオプションを備えています。出力のソート、単位の指定、選択基準の使用、および lvm.conf ファイルの更新を行って LVM レポートをカスタマイズできます。

7.1. LVM 表示の形式の制御

追加オプションなしで pvs、lvs、または vgs コマンドを使用すると、デフォルトの並べ替え順序でデフォルトのフィールドセットが表示されます。pvs コマンドのデフォルトフィールドには、物理ボリュームの名前で並べ替えられた次の情報が含まれています。

# pvs

PV VG Fmt Attr PSize PFree

/dev/vdb1 VolumeGroupName lvm2 a-- 17.14G 17.14G

/dev/vdb2 VolumeGroupName lvm2 a-- 17.14G 17.09G

/dev/vdb3 VolumeGroupName lvm2 a-- 17.14G 17.14GPV- 物理ボリューム名。

VG- ボリュームグループ名。

Fmt-

物理ボリュームのメタデータ形式:

lvm2またはlvm1。 Attr- 物理ボリュームのステータス: (a) - 割り当て可能、または (x) - エクスポート済み。

PSize- 物理ボリュームのサイズ。

PFree- 物理ボリュームにある残りの空き領域。

カスタムフィールドの表示

デフォルトとは異なるフィールドセットを表示するには、-o オプションを使用します。次の例では、物理ボリュームの名前、サイズ、空き容量のみを表示します。

# pvs -o pv_name,pv_size,pv_free

PV PSize PFree

/dev/vdb1 17.14G 17.14G

/dev/vdb2 17.14G 17.09G

/dev/vdb3 17.14G 17.14GLVM 表示の並べ替え

特定の基準で結果を並べ替えるには、-O オプションを使用します。次の例では、エントリーを物理ボリュームの空き領域で昇順に並べ替えます。

# pvs -o pv_name,pv_size,pv_free -O pv_free

PV PSize PFree

/dev/vdb2 17.14G 17.09G

/dev/vdb1 17.14G 17.14G

/dev/vdb3 17.14G 17.14G

結果を降順で並べ替えるには、- 文字とともに -O オプションを使用します。

# pvs -o pv_name,pv_size,pv_free -O -pv_free

PV PSize PFree

/dev/vdb1 17.14G 17.14G

/dev/vdb3 17.14G 17.14G

/dev/vdb2 17.14G 17.09G関連情報

-

システム上の

lvmreport(7)、lvs(8)、vgs(8)、pvs(8)man ページ - LVM 表示の単位の指定

- LVM 設定ファイルのカスタマイズ

7.2. LVM 表示の単位の指定

LVM 表示コマンドの --units 引数を指定すると、LVM デバイスのサイズを 2 進数単位または 10 進数単位で表示できます。すべての引数については次の表を参照してください。

| 単位の種類 | 説明 | 利用可能なオプション | デフォルト |

|---|---|---|---|

| 2 進数単位 | 単位は 2 の累乗 (1024 の倍数) で表示されます。 |

|

|

| 10 進数単位 | 単位は 1000 の倍数で表示されます。 |

| 該当なし |

| カスタム単位 |

数量と 2 進数または 10 進数の単位の組み合わせ。たとえば、結果を 4 メビバイトで表示するには、 | 該当なし | 該当なし |

単位の値を指定しない場合は、人間が判読できる形式 (

r) がデフォルトで使用されます。次のvgsコマンドは、VG のサイズを人間が判読できる形式で表示します。最適な単位が使用されます。また、丸め記号<によって、実際のサイズが近似値であり、931 ギビバイト未満であることが示されます。# vgs myvg VG #PV #LV #SN Attr VSize VFree myvg 1 1 0 wz-n <931.00g <930.00g次の

pvsコマンドは、/dev/vdb物理ボリュームの出力を 2 進数のギビバイト単位で表示します。# pvs --units g /dev/vdb PV VG Fmt Attr PSize PFree /dev/vdb myvg lvm2 a-- 931.00g 930.00g次の

pvsコマンドは、/dev/vdb物理ボリュームの出力を 10 進数のギガバイト単位で表示します。# pvs --units G /dev/vdb PV VG Fmt Attr PSize PFree /dev/vdb myvg lvm2 a-- 999.65G 998.58G次の

pvsコマンドは、出力を 512 バイトのセクター単位で表示します。# pvs --units s PV VG Fmt Attr PSize PFree /dev/vdb myvg lvm2 a-- 1952440320S 1950343168SLVM 表示コマンドには、カスタム単位を指定できます。次の例では、

pvsコマンドの出力を 4 メビバイト単位で表示します。# pvs --units 4m PV VG Fmt Attr PSize PFree /dev/vdb myvg lvm2 a-- 238335.00U 238079.00U

7.3. LVM 設定ファイルのカスタマイズ

lvm.conf ファイルを編集することで、お客様固有のストレージおよびシステム要件に応じて LVM 設定をカスタマイズできます。たとえば、lvm.conf ファイルを編集して、フィルター設定の変更、ボリュームグループの自動アクティブ化の設定、シンプールの管理、またはスナップショットの自動拡張を行うことができます。

手順:

-

任意のエディターで

lvm.confファイルを開きます。 デフォルトの表示値を変更する設定のコメントを解除して変更し、

lvm.confファイルをカスタマイズします。lvsの出力に表示されるフィールドをカスタマイズするには、lvs_colsパラメーターのコメントを解除して変更します。lvs_cols="lv_name,vg_name,lv_attr"

pvs、vgs、lvsコマンドの空のフィールドを非表示にするには、compact_output=1設定のコメントを解除します。compact_output = 1

pvs、vgs、およびlvsコマンドのデフォルトの単位としてギガバイトを設定するには、units = "r"設定をunits = "G"に置き換えます。units = "G"

lvm.confファイルの対応するセクションのコメントが解除されていることを確認します。たとえば、lvs_colsパラメーターを変更するには、reportセクションのコメントを解除する必要があります。report { ... }

検証

lvm.confファイルを変更した後、変更した値を表示します。# lvmconfig --typeconfig diff

関連情報

-

システム上の

lvm.conf(5)man ページ

7.4. LVM 選択基準の定義

選択基準は、<field> <operator> <value> 形式の一連のステートメントであり、比較演算子を使用して特定のフィールドの値を定義します。選択基準に一致するオブジェクトが処理または表示されます。オブジェクトは、物理ボリューム (PV)、ボリュームグループ (VG)、または論理ボリューム (LV) です。ステートメントは、論理演算子とグループ化演算子によって結合します。

選択基準を定義するには、-S または --select オプションの後に 1 つまたは複数のステートメントを使用します。

-S オプションは、各オブジェクトに名前を付けるのではなく、処理するオブジェクトを記述することによって機能します。これは、多くのオブジェクトを処理する場合や、各オブジェクトを個別に検索して名前を付けることが難しい場合や、複雑な特性セットを持つオブジェクトを検索する場合に役立ちます。-S オプションは、多くの名前を入力しなくても済むようにショートカットとして使用することもできます。

フィールドと使用可能な演算子の完全なセットを表示するには、lvs -S help コマンドを使用します。lvs をレポートまたは処理コマンドに置き換えると、そのコマンドの詳細が表示されます。

-

レポートコマンドには、

pvs、vgs、lvs、pvdisplay、vgdisplay、lvdisplay、およびdmsetup info -cが含まれます。 -

処理コマンドには、

pvchange、vgchange、lvchange、vgimport、vgexport、vgremove、およびlvremoveが含まれます。

pvs コマンドを使用した選択基準の例

次の

pvsコマンドの例では、名前に文字列nvmeが含まれる物理ボリュームのみが表示されます。# pvs -S name=~nvme PV Fmt Attr PSize PFree /dev/nvme2n1 lvm2 --- 1.00g 1.00g次の

pvsコマンドの例では、myvgボリュームグループ内の物理デバイスのみが表示されます。# pvs -S vg_name=myvg PV VG Fmt Attr PSize PFree /dev/vdb1 myvg lvm2 a-- 1020.00m 396.00m /dev/vdb2 myvg lvm2 a-- 1020.00m 896.00m

lvs コマンドを使用した選択基準の例

次の

lvsコマンドの例では、サイズが 100 m より大きく 200 m 未満の論理ボリュームのみが表示されます。# lvs -S 'size > 100m && size < 200m' LV VG Attr LSize Cpy%Sync rr myvg rwi-a-r--- 120.00m 100.00次の

lvsコマンドの例では、名前にlvolと 0 から 2 までの任意の数字が含まれる論理ボリュームのみが表示されます。# lvs -S name=~lvol[02] LV VG Attr LSize lvol0 myvg -wi-a----- 100.00m lvol2 myvg -wi------- 100.00m次の

lvsコマンドの例では、raid1セグメントタイプを持つ論理ボリュームのみが表示されます。# lvs -S segtype=raid1 LV VG Attr LSize Cpy%Sync rr myvg rwi-a-r--- 120.00m 100.00

高度な例

選択基準を他のオプションと組み合わせることができます。

次の

lvchangeコマンドの例では、アクティブな論理ボリュームにのみ特定のタグmytagを追加します。# lvchange --addtag mytag -S active=1 Logical volume myvg/mylv changed. Logical volume myvg/lvol0 changed. Logical volume myvg/lvol1 changed. Logical volume myvg/rr changed.次の

lvsコマンドの例では、名前が_pmspareと一致しないすべての論理ボリュームを表示し、デフォルトのヘッダーをカスタムのものに変更します。# lvs -a -o lv_name,vg_name,attr,size,pool_lv,origin,role -S 'name!~_pmspare' LV VG Attr LSize Pool Origin Role thin1 example Vwi-a-tz-- 2.00g tp public,origin,thinorigin thin1s example Vwi---tz-- 2.00g tp thin1 public,snapshot,thinsnapshot thin2 example Vwi-a-tz-- 3.00g tp public tp example twi-aotz-- 1.00g private [tp_tdata] example Twi-ao---- 1.00g private,thin,pool,data [tp_tmeta] example ewi-ao---- 4.00m private,thin,pool,metadata次の

lvchangeコマンドの例では、role=thinsnapshotおよびorigin=thin1の論理ボリュームを、通常のアクティブ化コマンドの実行中にスキップするようにフラグ付けします。# lvchange --setactivationskip n -S 'role=thinsnapshot && origin=thin1' Logical volume myvg/thin1s changed.次の

lvsコマンドの例では、次の 3 つの条件すべてに一致する論理ボリュームのみが表示されます。-

名前に

_tmetaが含まれている。 -

ロールが

metadataである。 - サイズが 4m 以下である。

# lvs -a -S 'name=~_tmeta && role=metadata && size <= 4m' LV VG Attr LSize [tp_tmeta] myvg ewi-ao---- 4.00m-

名前に

関連情報

-

システム上の

lvmreport(7)man ページ

第9章 RAID 論理ボリュームの設定

論理ボリュームマネージャー (LVM) を使用して、Redundant Array of Independent Disks (RAID) ボリュームを作成および管理できます。LVM は、RAID レベル 0、1、4、5、6、10 に対応します。LVM RAID ボリュームには以下の特徴があります。

- LVM は、Multiple Devices (MD) カーネルドライバーを活用した RAID 論理ボリュームを作成して管理する

- アレイから RAID1 イメージを一時的に分割し、後でアレイにマージし直すことが可能

- LVM RAID ボリュームはスナップショットに対応

- RAID 論理ボリュームはクラスターには対応していません。RAID 論理ボリュームは 1 台のマシンに排他的に作成およびアクティブ化できますが、複数のマシンで同時にアクティブにすることはできません。

-

RAID 論理ボリューム (LV) を作成するとき、LVM は、データまたはアレイ内のパリティーサブボリュームごとに、サイズが 1 エクステントのメタデータサブボリュームを作成します。たとえば、2 方向の RAID1 アレイを作成すると、メタデータサブボリュームが 2 つ (

lv_rmeta_0およびlv_rmeta_1) と、データサブボリュームが 2 つ (lv_rimage_0およびlv_rimage_1) 作成されます。 - RAID LV に整合性を追加すると、ソフト破損が軽減または防止されます。

9.1. RAID レベルとリニアサポート

レベル 0、1、4、5、6、10、リニアなど、RAID 別の対応設定は以下のとおりです。

- レベル 0

ストライピングとも呼ばれる RAID レベル 0 は、パフォーマンス指向のストライピングデータマッピング技術です。これは、アレイに書き込まれるデータがストライプに分割され、アレイのメンバーディスク全体に書き込まれることを意味します。これにより低い固有コストで高い I/O パフォーマンスを実現できますが、冗長性は提供されません。

RAID レベル 0 実装は、アレイ内の最小デバイスのサイズまで、メンバーデバイス全体にだけデータをストライピングします。つまり、複数のデバイスのサイズが少し異なる場合、それぞれのデバイスは最小ドライブと同じサイズであるかのように処理されます。したがって、レベル 0 アレイの共通ストレージ容量は、すべてのディスクの合計容量です。メンバーディスクのサイズが異なる場合、RAID0 は使用可能なゾーンを使用して、それらのディスクのすべての領域を使用します。

- レベル 1

RAID レベル 1 (ミラーリング) は、アレイの各メンバーディスクに同一のデータを書き込み、ミラー化されたコピーを各ディスクに残すことによって冗長性を提供します。ミラーリングは、データの可用性の単純化と高レベルにより、いまでも人気があります。レベル 1 は 2 つ以上のディスクと連携して、非常に優れたデータ信頼性を提供し、読み取り集中型のアプリケーションに対してパフォーマンスが向上しますが、比較的コストが高くなります。

RAID レベル 1 は、アレイ内のすべてのディスクに同じ情報を書き込むためコストがかかります。これにより、データの信頼性が提供されますが、レベル 5 などのパリティーベースの RAID レベルよりもスペース効率が大幅に低下します。ただし、この領域の非効率性にはパフォーマンス上の利点があります。パリティーベースの RAID レベルは、パリティーを生成するためにかなり多くの CPU 電力を消費しますが、RAID レベル 1 は単に同じデータを、CPU オーバーヘッドが非常に少ない複数の RAID メンバーに複数回書き込むだけです。そのため、RAID レベル 1 は、ソフトウェア RAID が使用されているマシンや、マシンの CPU リソースが一貫して RAID アクティビティー以外の操作でアレイ化されます。

レベル 1 アレイのストレージ容量は、ハードウェア RAID 内でミラーリングされている最小サイズのハードディスクの容量と同じか、ソフトウェア RAID 内でミラーリングされている最小のパーティションと同じ容量になります。レベル 1 の冗長性は、すべての RAID タイプの中で最も高いレベルであり、アレイは 1 つのディスクのみで動作できます。

- レベル 4

レベル 4 は、1 つのディスクドライブでパリティー連結を使用して、データを保護します。パリティー情報は、アレイ内の残りのメンバーディスクのコンテンツに基づいて計算されます。この情報は、アレイ内のいずれかのディスクに障害が発生した場合にデータの再構築に使用できます。その後、再構築されたデータを使用して、交換前に失敗したディスクに I/O 要求に対応でき、交換後に失敗したディスクを接続します。

パリティー専用ディスクは、RAID アレイへのすべての書き込みトランザクションにおいて固有のボトルネックとなるため、ライトバックキャッシングなどの付随する技術なしにレベル 4 が使用されることはほとんどありません。または、システム管理者が意図的にこのボトルネックを考慮してソフトウェア RAID デバイスを設計している特定の状況下で使用されます。たとえば、アレイにデータが格納されると書き込みトランザクションがほとんどないようなアレイです。RAID レベル 4 にはほとんど使用されないため、Anaconda ではこのオプションとしては使用できません。ただし、実際には必要な場合は、ユーザーが手動で作成できます。

ハードウェア RAID レベル 4 のストレージ容量は、最小メンバーパーティションの容量にパーティションの数を掛けて 1 を引いた値に等しくなります。RAID レベル 4 アレイのパフォーマンスは常に非対称です。つまり、読み込みは書き込みを上回ります。これは、パリティーを生成するときに書き込み操作が余分な CPU リソースとメインメモリー帯域幅を消費し、実際のデータをディスクに書き込むときに余分なバス帯域幅も消費するためです。これは、データだけでなくパリティーも書き込むためです。読み取り操作は、アレイが劣化状態にない限り、データを読み取るだけでパリティーを読み取る必要はありません。その結果、読み取り操作では、通常の操作条件下で同じ量のデータ転送を行う場合でも、ドライブおよびコンピューターのバス全体に生成されるトラフィックが少なくなります。

- レベル 5

これは RAID の最も一般的なタイプです。RAID レベル 5 は、アレイのすべてのメンバーディスクドライブにパリティーを分散することにより、レベル 4 に固有の書き込みボトルネックを排除します。パリティー計算プロセス自体のみがパフォーマンスのボトルネックです。最近の CPU はパリティーを非常に高速に計算できます。しかし、RAID 5 アレイに多数のディスクを使用していて、すべてのデバイスの合計データ転送速度が十分に高い場合、パリティー計算がボトルネックになる可能性があります。

レベル 5 のパフォーマンスは非対称であり、読み取りは書き込みよりも大幅に優れています。RAID レベル 5 のストレージ容量は、レベル 4 と同じです。

- レベル 6

パフォーマンスではなくデータの冗長性と保存が最重要事項であるが、レベル 1 の領域の非効率性が許容できない場合は、これが RAID の一般的なレベルです。レベル 6 では、複雑なパリティースキームを使用して、アレイ内の 2 つのドライブから失われたドライブから復旧できます。複雑なパリティースキームにより、ソフトウェア RAID デバイスで CPU 幅が大幅に高くなり、書き込みトランザクションの際に増大度が高まります。したがって、レベル 6 はレベル 4 や 5 よりもパフォーマンスにおいて、非常に非対称です。

RAID レベル 6 アレイの合計容量は、RAID レベル 5 および 4 と同様に計算されますが、デバイス数から追加パリティーストレージ領域用に 2 つのデバイス (1 ではなく) を引きます。

- レベル 10

この RAID レベルでは、レベル 0 のパフォーマンスとレベル 1 の冗長性を組み合わせます。また、2 台以上のデバイスを使用するレベル 1 アレイの無駄なスペースをある程度削減することができます。レベル 10 では、たとえば、データごとに 2 つのコピーのみを格納するように設定された 3 ドライブアレイを作成することができます。これにより、全体用のアレイサイズを最小デバイスのみと同じサイズ (3 つのデバイス、レベル 1 アレイなど) ではなく、最小デバイスのサイズの 1.5 倍にすることができます。これにより、CPU プロセスの使用量が RAID レベル 6 のようにパリティーを計算するのを防ぎますが、これは領域効率が悪くなります。

RAID レベル 10 の作成は、インストール時には対応していません。インストール後に手動で作成できます。

- リニア RAID

リニア RAID は、より大きな仮想ドライブを作成するドライブのグループ化です。

リニア RAID では、あるメンバードライブからチャンクが順次割り当てられます。最初のドライブが完全に満杯になったときにのみ次のドライブに移動します。これにより、メンバードライブ間の I/O 操作が分割される可能性はないため、パフォーマンスの向上は見られません。リニア RAID は冗長性がなく、信頼性は低下します。メンバードライブが 1 台でも故障すると、アレイ全体が使用できなくなり、データが失われる可能性があります。容量はすべてのメンバーディスクの合計になります。

9.2. LVM RAID のセグメントタイプ

RAID 論理ボリュームを作成するには、RAID タイプを lvcreate コマンドの --type 引数として指定します。ほとんどのユーザーの場合、raid1、raid4、raid5、raid6、raid10 の 5 つの使用可能なプライマリータイプのいずれかを指定するだけで十分です。

以下の表は、考えられる RAID セグメントタイプを示しています。

| セグメントタイプ | 説明 |

|---|---|

|

|

RAID1 ミラーリング。 |

|

| RAID4 専用パリティーディスク |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

| ストライピング。RAID0 では、ストライプサイズの単位で、複数のデータサブボリュームに論理ボリュームデータが分散されます。これは、パフォーマンスを向上させるために使用します。論理ボリュームのデータは、いずれかのデータサブボリュームで障害が発生すると失われます。 |

9.3. RAID0 を作成するためのパラメーター

RAID0 ストライピング論理ボリュームは、lvcreate --type raid0[meta] --stripes _Stripes --stripesize StripeSize VolumeGroup [PhysicalVolumePath] コマンドを使用して作成することができます。

次の表は、RAID0 ストライピング論理ボリュームを作成するときに使用できるさまざまなパラメーターを説明しています。

| パラメーター | 説明 |

|---|---|

|

|

|

|

| 論理ボリュームを分散するデバイスの数を指定します。 |

|

| 各ストライプのサイズをキロバイト単位で指定します。これは、次のデバイスに移動する前にデバイスに書き込まれるデータの量です。 |

|

| 使用するボリュームグループを指定します。 |

|

| 使用するデバイスを指定します。指定しない場合は、LVM により、Stripes オプションに指定されているデバイスの数が、各ストライプに 1 つずつ選択されます。 |

9.4. RAID 論理ボリュームの作成

-m 引数に指定する値に応じて、複数のコピーを持つ RAID1 アレイを作成できます。同様に、-i 引数を使用して、RAID 0、4、5、6、10 論理ボリュームのストライピング数を指定できます。-I 引数で、ストライプのサイズを指定することもできます。以下の手順では、異なるタイプの RAID 論理ボリュームを作成するさまざまな方法を説明します。

手順

2 方向 RAID を作成します。以下のコマンドは、ボリュームグループ my_vg 内にサイズが 1G の 2 方向 RAID1 アレイ my_lv を作成します。

# lvcreate --type raid1 -m 1 -L 1G -n my_lv my_vg Logical volume "my_lv" created.

ストライピングで RAID5 アレイを作成します。次のコマンドは、ボリュームグループ my_vg に、3 つのストライプと 1 つの暗黙のパリティードライブ (my_lv) を持つ、サイズが 1G の RAID5 アレイを作成します。LVM ストライピングボリュームと同様にストライピングの数を指定できることに注意してください。正しい数のパリティードライブが自動的に追加されます。

# lvcreate --type raid5 -i 3 -L 1G -n my_lv my_vgストライピングで RAID6 アレイを作成します。次のコマンドは、ボリュームグループ my_vg に 3 つの 3 ストライプと 2 つの暗黙的なパリティードライブ (my_lv という名前) を持つ RAID6 アレイを作成します。これは、1G 1 ギガバイトのサイズです。

# lvcreate --type raid6 -i 3 -L 1G -n my_lv my_vg

検証

2 ウェイ RAID1 アレイである LVM デバイス my_vg/my_lv を表示します。

# lvs -a -o name,copy_percent,devices my_vg LV Copy% Devices my_lv 6.25 my_lv_rimage_0(0),my_lv_rimage_1(0) [my_lv_rimage_0] /dev/sde1(0) [my_lv_rimage_1] /dev/sdf1(1) [my_lv_rmeta_0] /dev/sde1(256) [my_lv_rmeta_1] /dev/sdf1(0)

関連情報

-

システム上の

lvcreate(8)およびlvmraid(7)man ページ

9.5. storage RHEL システムロールを使用して RAID を備えた LVM プールを設定する

storage システムロールを使用すると、Red Hat Ansible Automation Platform を使用して、RAID を備えた LVM プールを RHEL に設定できます。利用可能なパラメーターを使用して Ansible Playbook を設定し、RAID を備えた LVM プールを設定できます。

前提条件

- コントロールノードと管理対象ノードの準備が完了している。

- 管理対象ノードで Playbook を実行できるユーザーとしてコントロールノードにログインしている。

-

管理対象ノードへの接続に使用するアカウントに、そのノードに対する

sudo権限がある。

手順

次の内容を含む Playbook ファイル (例:

~/playbook.yml) を作成します。--- - name: Manage local storage hosts: managed-node-01.example.com tasks: - name: Configure LVM pool with RAID ansible.builtin.include_role: name: rhel-system-roles.storage vars: storage_safe_mode: false storage_pools: - name: my_pool type: lvm disks: [sdh, sdi] raid_level: raid1 volumes: - name: my_volume size: "1 GiB" mount_point: "/mnt/app/shared" fs_type: xfs state: presentPlaybook で使用されるすべての変数の詳細は、コントロールノードの

/usr/share/ansible/roles/rhel-system-roles.storage/README.mdファイルを参照してください。Playbook の構文を検証します。

$ ansible-playbook --syntax-check ~/playbook.ymlこのコマンドは構文を検証するだけであり、有効だが不適切な設定から保護するものではないことに注意してください。

Playbook を実行します。

$ ansible-playbook ~/playbook.yml

検証

プールが RAID 上にあることを確認します。

# ansible managed-node-01.example.com -m command -a 'lsblk'

関連情報

-

/usr/share/ansible/roles/rhel-system-roles.storage/README.mdファイル -

/usr/share/doc/rhel-system-roles/storage/ディレクトリー - RAID の管理

9.6. RAID0 ストライプ化論理ボリュームの作成

RAID0 論理ボリュームは、論理ボリュームデータをストライプサイズ単位で複数のデータサブボリューム全体に分散します。以下の手順では、ディスク間でデータをストライピングする mylv という LVM RAID0 論理ボリュームを作成します。

前提条件

- 3 つ以上の物理ボリュームを作成している。物理ボリュームの作成方法は、LVM 物理ボリュームの作成 を参照してください。

- ボリュームグループを作成している。詳細は、LVM ボリュームグループの作成 を参照してください。

手順

既存のボリュームグループから RAID0 論理ボリュームを作成します。次のコマンドは、ボリュームグループ myvg から RAID0 ボリューム mylv を作成します。このボリュームは、サイズが 2G で、ストライプが 3 つあります。ストライプのサイズは 4kB です。

# lvcreate --type raid0 -L 2G --stripes 3 --stripesize 4 -n mylv my_vg Rounding size 2.00 GiB (512 extents) up to stripe boundary size 2.00 GiB(513 extents). Logical volume "mylv" created.

RAID0 論理ボリュームにファイルシステムを作成します。以下のコマンドを使用すると、論理ボリュームに ext4 ファイルシステムが作成されます。

# mkfs.ext4 /dev/my_vg/mylv論理ボリュームをマウントして、ファイルシステムのディスクの領域使用率を報告します。

# mount /dev/my_vg/mylv /mnt # df Filesystem 1K-blocks Used Available Use% Mounted on /dev/mapper/my_vg-mylv 2002684 6168 1875072 1% /mnt

検証

作成された RAID0 ストライピング論理ボリュームを表示します。

# lvs -a -o +devices,segtype my_vg LV VG Attr LSize Pool Origin Data% Meta% Move Log Cpy%Sync Convert Devices Type mylv my_vg rwi-a-r--- 2.00g mylv_rimage_0(0),mylv_rimage_1(0),mylv_rimage_2(0) raid0 [mylv_rimage_0] my_vg iwi-aor--- 684.00m /dev/sdf1(0) linear [mylv_rimage_1] my_vg iwi-aor--- 684.00m /dev/sdg1(0) linear [mylv_rimage_2] my_vg iwi-aor--- 684.00m /dev/sdh1(0) linear

9.7. storage RHEL システムロールを使用して RAID LVM ボリュームのストライプサイズを設定する

storage システムロールを使用すると、Red Hat Ansible Automation Platform を使用して、RHEL の RAID LVM ボリュームのストライプサイズを設定できます。利用可能なパラメーターを使用して Ansible Playbook を設定し、RAID を備えた LVM プールを設定できます。

前提条件

- コントロールノードと管理対象ノードの準備が完了している。

- 管理対象ノードで Playbook を実行できるユーザーとしてコントロールノードにログインしている。

-

管理対象ノードへの接続に使用するアカウントに、そのノードに対する

sudo権限がある。

手順

次の内容を含む Playbook ファイル (例:

~/playbook.yml) を作成します。--- - name: Manage local storage hosts: managed-node-01.example.com tasks: - name: Configure stripe size for RAID LVM volumes ansible.builtin.include_role: name: rhel-system-roles.storage vars: storage_safe_mode: false storage_pools: - name: my_pool type: lvm disks: [sdh, sdi] volumes: - name: my_volume size: "1 GiB" mount_point: "/mnt/app/shared" fs_type: xfs raid_level: raid0 raid_stripe_size: "256 KiB" state: presentPlaybook で使用されるすべての変数の詳細は、コントロールノードの

/usr/share/ansible/roles/rhel-system-roles.storage/README.mdファイルを参照してください。Playbook の構文を検証します。

$ ansible-playbook --syntax-check ~/playbook.ymlこのコマンドは構文を検証するだけであり、有効だが不適切な設定から保護するものではないことに注意してください。

Playbook を実行します。

$ ansible-playbook ~/playbook.yml

検証

ストライプサイズが必要なサイズに設定されていることを確認します。

# ansible managed-node-01.example.com -m command -a 'lvs -o+stripesize /dev/my_pool/my_volume'

関連情報

-

/usr/share/ansible/roles/rhel-system-roles.storage/README.mdファイル -