仮想化

OpenShift Virtualization のインストール、使用方法、およびリリースノート

概要

第1章 概要

1.1. OpenShift Virtualization について

OpenShift Virtualization の機能およびサポート範囲について確認します。

1.1.1. OpenShift Virtualization の機能

OpenShift virtualization は OpenShift Container Platform のアドオンであり、仮想マシンのワークロードを実行し、このワークロードをコンテナーのワークロードと共に管理することを可能にします。

OpenShift Virtualization は、Kubernetes カスタムリソースにより新規オブジェクトを OpenShift Container Platform クラスターに追加し、仮想化タスクを有効にします。これらのタスクには、以下が含まれます。

- Linux および Windows 仮想マシン (VM) の作成と管理

- クラスター内で Pod と 仮想マシンのワークロードの同時実行

- 各種コンソールおよび CLI ツールの使用による仮想マシンへの接続

- 既存の仮想マシンのインポートおよびクローン作成

- ネットワークインターフェイスコントローラーおよび仮想マシンに割り当てられたストレージディスクの管理

- 仮想マシンのノード間でのライブマイグレーション

機能強化された Web コンソールは、これらの仮想化されたリソースを OpenShift Container Platform クラスターコンテナーおよびインフラストラクチャーと共に管理するためのグラフィカルポータルを提供します。

OpenShift Virtualization は、Red Hat OpenShift Data Foundation の機能とうまく連携するように設計およびテストされています。

OpenShift Data Foundation を使用して OpenShift Virtualization をデプロイする場合は、Windows 仮想マシンディスク用の専用ストレージクラスを作成する必要があります。詳細は 、Windows VM の ODF PersistentVolumes の最適化 を参照してください。

OpenShift Virtualization は、OVN-Kubernetes、OpenShift SDN、または 認定 OpenShift CNI プラグイン にリストされているその他の認定ネットワークプラグインのいずれかで使用できます。

Compliance Operator をインストールし、ocp4-moderate および ocp4-moderate-node プロファイル を使用してスキャンを実行することにより、OpenShift Virtualization クラスターのコンプライアンスの問題を確認できます。Compliance Operator は、NIST 認定ツール である OpenSCAP を使用して、セキュリティーポリシーをスキャンし、適用します。

1.1.1.1. OpenShift Virtualization サポートのクラスターバージョン

OpenShift Virtualization 4.14 は OpenShift Container Platform 4.14 クラスターで使用するためにサポートされます。Open Shift Virtualization の最新の z-stream リリースを使用するには、最初に Open Shift Container Platform の最新バージョンにアップグレードする必要があります。

1.1.2. 仮想マシンディスクのボリュームとアクセスモードについて

既知のストレージプロバイダーでストレージ API を使用する場合、ボリュームモードとアクセスモードは自動的に選択されます。ただし、ストレージプロファイルのないストレージクラスを使用する場合は、ボリュームとアクセスモードを設定する必要があります。

最良の結果を得るには、ReadWriteMany (RWX) アクセスモードと Block ボリュームモードを使用してください。これは、以下の理由により重要です。

-

ライブマイグレーションには

ReadWriteMany(RWX) アクセスモードが必要です。 Blockボリュームモードは、Filesystemボリュームモードよりもパフォーマンスが大幅に優れています。これは、Filesystemボリュームモードでは、ファイルシステムレイヤーやディスクイメージファイルなどを含め、より多くのストレージレイヤーが使用されるためです。仮想マシンのディスクストレージに、これらのレイヤーは必要ありません。たとえば、Red Hat OpenShift Data Foundation を使用する場合は、CephFS ボリュームよりも Ceph RBD ボリュームの方が推奨されます。

次の設定の仮想マシンをライブマイグレーションすることはできません。

-

ReadWriteOnce(RWO) アクセスモードのストレージボリューム - GPU などのパススルー機能

それらの仮想マシンの evictionStrategy フィールドを LiveMigrate に設定しないでください。

1.1.3. 単一ノードの Openshift の違い

OpenShift Virtualization は単一ノード OpenShift にインストールできます。

ただし、単一ノード OpenShift は次の機能をサポートしていないことに注意してください。

- 高可用性

- Pod の中断

- ライブマイグレーション

- エビクション戦略が設定されている仮想マシンまたはテンプレート

1.1.4. 関連情報

1.2. セキュリティーポリシー

OpenShift Virtualization のセキュリティーと認可について説明します。

主なポイント

-

OpenShift Virtualization は、Pod セキュリティーの現在のベストプラクティスを強制することを目的とした、

restrictedKubernetes pod security standards プロファイルに準拠しています。 - 仮想マシン (VM) のワークロードは、特権のない Pod として実行されます。

-

セキュリティーコンテキスト制約 (SCC) は、

kubevirt-controllerサービスアカウントに対して定義されます。 - OpenShift Virtualization コンポーネントの TLS 証明書は更新され、自動的にローテーションされます。

1.2.1. ワークロードのセキュリティーについて

デフォルトでは、OpenShift Virtualization の仮想マシン (VM) ワークロードは root 権限では実行されず、root 権限を必要とするサポート対象の OpenShift Virtualization 機能はありません。

仮想マシンごとに、virt-launcher Pod が libvirt のインスタンスを セッションモード で実行し、仮想マシンプロセスを管理します。セッションモードでは、libvirt デーモンは root 以外のユーザーアカウントとして実行され、同じユーザー識別子 (UID) で実行されているクライアントからの接続のみを許可します。したがって、仮想マシンは権限のない Pod として実行し、最小権限のセキュリティー原則に従います。

1.2.2. TLS 証明書

OpenShift Virtualization コンポーネントの TLS 証明書は更新され、自動的にローテーションされます。手動で更新する必要はありません。

自動更新スケジュール

TLS 証明書は自動的に削除され、以下のスケジュールに従って置き換えられます。

- KubeVirt 証明書は毎日更新されます。

- Containerized Data Importer controller (CDI) 証明書は、15 日ごとに更新されます。

- MAC プール証明書は毎年更新されます。

TLS 証明書の自動ローテーションはいずれの操作も中断しません。たとえば、以下の操作は中断せずに引き続き機能します。

- 移行

- イメージのアップロード

- VNC およびコンソールの接続

1.2.3. 認可

OpenShift Virtualization は、ロールベースのアクセス制御 (RBAC) を使用して、人間のユーザーとサービスアカウントの権限を定義します。サービスアカウントに定義された権限は、OpenShift Virtualization コンポーネントが実行できるアクションを制御します。

RBAC ロールを使用して、仮想化機能へのユーザーアクセスを管理することもできます。たとえば管理者は、仮想マシンの起動に必要な権限を提供する RBAC ロールを作成できます。管理者は、ロールを特定のユーザーにバインドすることでアクセスを制限できます。

1.2.3.1. OpenShift Virtualization のデフォルトのクラスターロール

クラスターロール集約を使用することで、OpenShift Virtualization はデフォルトの OpenShift Container Platform クラスターロールを拡張して、仮想化オブジェクトにアクセスするための権限を組み込みます。

表1.1 OpenShift Virtualization のクラスターロール

| デフォルトのクラスターロール | OpenShift Virtualization のクラスターロール | OpenShift Virtualization クラスターロールの説明 |

|---|---|---|

|

|

| クラスター内の OpenShift Virtualization リソースをすべて表示できるユーザー。ただし、リソースの作成、削除、変更、アクセスはできません。たとえば、ユーザーは仮想マシン (VM) が実行中であることを確認できますが、それをシャットダウンしたり、そのコンソールにアクセスしたりすることはできません。 |

|

|

| クラスター内のすべての OpenShift Virtualization リソースを変更できるユーザー。たとえば、ユーザーは仮想マシンの作成、VM コンソールへのアクセス、仮想マシンの削除を行えます。 |

|

|

|

リソースコレクションの削除を含め、すべての OpenShift Virtualization リソースに対する完全な権限を持つユーザー。このユーザーは、 |

1.2.3.2. OpenShift Virtualization のストレージ機能の RBAC ロール

cdi-operator および cdi-controller サービスアカウントを含む、次のパーミッションがコンテナー化データインポーター (CDI) に付与されます。

1.2.3.2.1. クラスター全体の RBAC のロール

表1.2 cdi.kubevirt.io API グループの集約されたクラスターロール

| CDI クラスターのロール | Resources | 動詞 |

|---|---|---|

|

|

|

|

|

|

| |

|

|

|

|

|

|

| |

|

|

|

|

|

|

| |

|

|

|

|

表1.3 cdi-operator サービスアカウントのクラスター全体のロール

| API グループ | Resources | 動詞 |

|---|---|---|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

許可リスト: |

|

|

|

許可リスト: |

|

|

|

|

|

表1.4 cdi-controller サービスアカウントのクラスター全体のロール

| API グループ | Resources | 動詞 |

|---|---|---|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

1.2.3.2.2. namespace 付きの RBAC ロール

表1.5 cdi-operator サービスアカウントの namespace ロール

| API グループ | Resources | 動詞 |

|---|---|---|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

表1.6 cdi-controller サービスアカウントの namespace ロール

| API グループ | Resources | 動詞 |

|---|---|---|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

1.2.3.3. kubevirt-controller サービスアカウントの追加の SCC とパーミッション

SCC (Security Context Constraints) は Pod のパーミッションを制御します。これらのパーミッションには、コンテナーのコレクションである Pod が実行できるアクションおよびそれがアクセスできるリソース情報が含まれます。SCC を使用して、Pod がシステムに受け入れられるために必要な Pod の実行に関する条件の一覧を定義できます。

virt-controller は、クラスター内の仮想マシンの virt-launcher Pod を作成するクラスターコントローラーです。これらの Pod には、kubevirt-controller サービスアカウントによってパーミッションが付与されます。

kubevirt-controller サービスアカウントには追加の SCC および Linux 機能が付与され、これにより適切なパーミッションを持つ virt-launcher Pod を作成できます。これらの拡張パーミッションにより、仮想マシンは通常の Pod の範囲外の OpenShift Virtualization 機能を利用できます。

kubevirt-controller サービスアカウントには以下の SCC が付与されます。

-

scc.AllowHostDirVolumePlugin = true

これは、仮想マシンが hostpath ボリュームプラグインを使用することを可能にします。 -

scc.AllowPrivilegedContainer = false

これは、virt-launcher Pod が権限付きコンテナーとして実行されないようにします。 scc.AllowedCapabilities = []corev1.Capability{"SYS_NICE", "NET_BIND_SERVICE"}-

SYS_NICEを使用すると、CPU アフィニティーを設定できます。 -

NET_BIND_SERVICEは、DHCP および Slirp 操作を許可します。

-

kubevirt-controller の SCC および RBAC 定義の表示

oc ツールを使用して kubevirt-controller の SecurityContextConstraints 定義を表示できます。

$ oc get scc kubevirt-controller -o yaml

oc ツールを使用して kubevirt-controller クラスターロールの RBAC 定義を表示できます。

$ oc get clusterrole kubevirt-controller -o yaml

1.2.4. 関連情報

1.3. OpenShift Virtualization アーキテクチャー

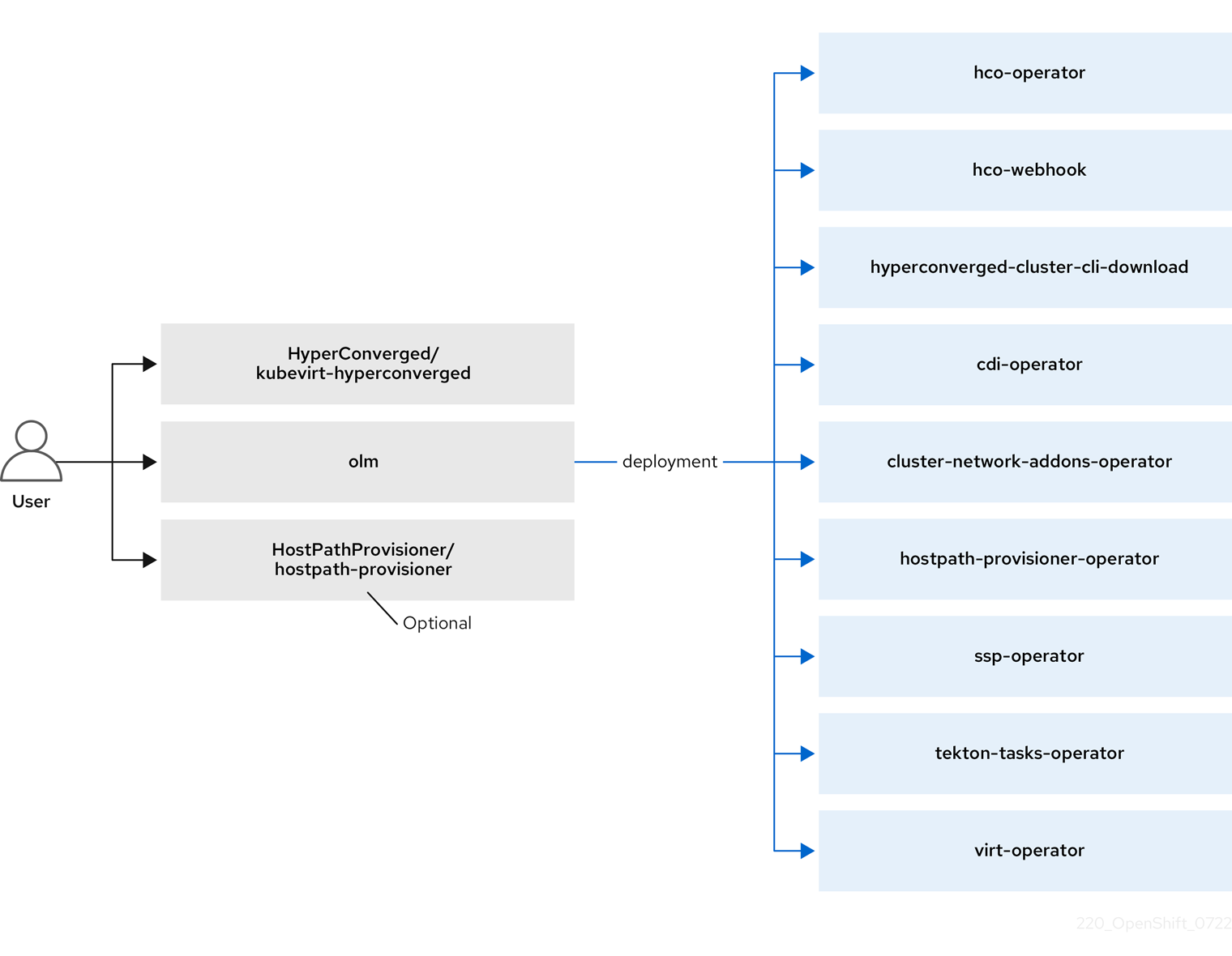

Operator Lifecycle Manager (OLM) は、OpenShift Virtualization の各コンポーネントのオペレーター Pod をデプロイします。

-

コンピューティング:

virt-operator -

ストレージ:

cdi-operator -

ネットワーク:

cluster-network-addons-operator -

スケーリング:

ssp-operator -

テンプレート作成:

tekton-tasks-operator

OLM は、他のコンポーネントのデプロイ、設定、およびライフサイクルを担当する hyperconverged-cluster-operator Pod と、いくつかのヘルパー Pod (hco-webhook および hyperconverged-cluster-cli-download) もデプロイします。

すべての Operator Pod が正常にデプロイされたら、HyperConverged カスタム リソース (CR) を作成する必要があります。HyperConverged CR で設定された設定は、信頼できる唯一の情報源および OpenShift Virtualization のエントリーポイントとして機能し、CR の動作をガイドします。

HyperConverged CR は、調整ループ内の他のすべてのコンポーネントの Operator に対応する CR を作成します。その後、各 Operator は、デーモンセット、config map、および OpenShift Virtualization コントロールプレーン用の追加コンポーネントなどのリソースを作成します。たとえば、HyperConverged Operator (HCO) が KubeVirt CR を作成すると、OpenShift Virtualization Operator がそれを調整し、virt-controller、virt-handler、virt-api などの追加リソースを作成します。

OLM は Hostpath Provisioner (HPP) Operator をデプロイしますが、hostpath-provisioner CR を作成するまで機能しません。

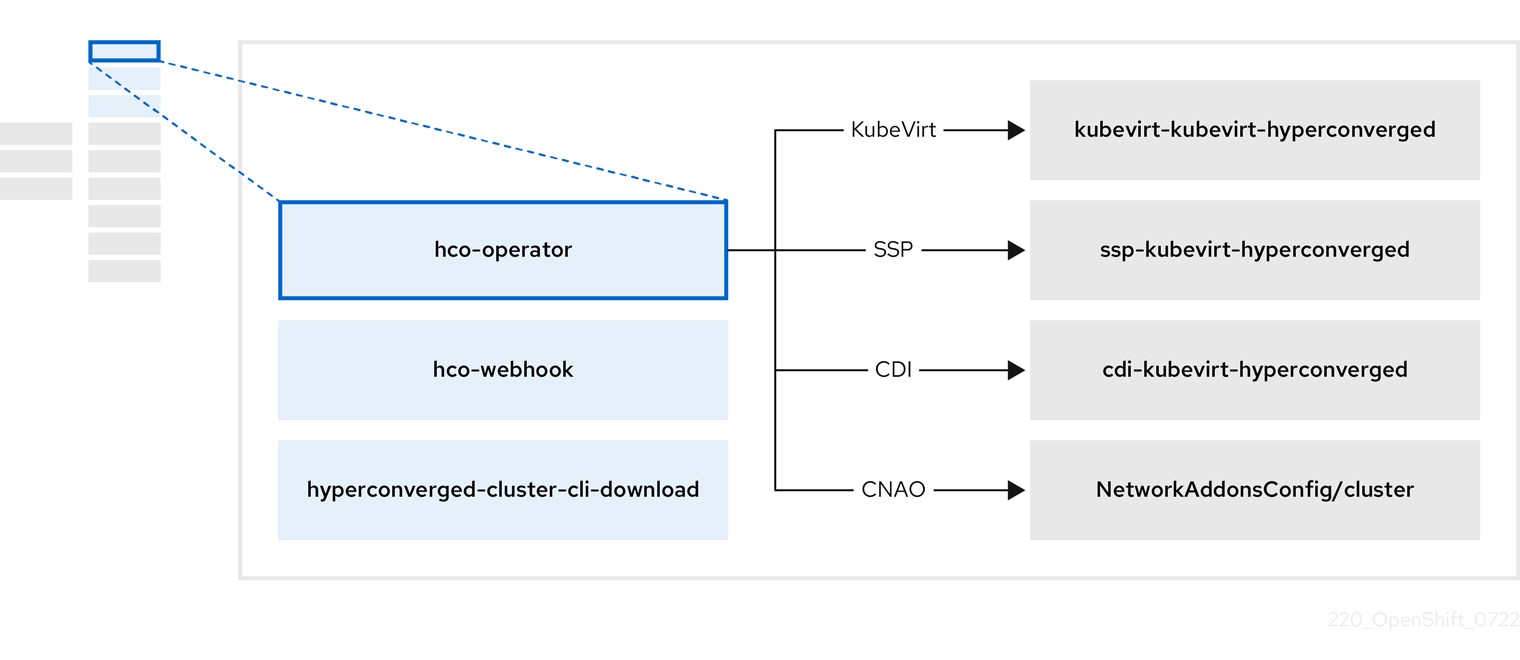

1.3.1. HyperConverged Operator (HCO) について

HCO (hco- operator) は、OpenShift Virtualization をデプロイおよび管理するための単一のエントリーポイントと、独自のデフォルトを持ついくつかのヘルパー Operator を提供します。また、これらの Operator のカスタム リソース (CR) も作成します。

表1.7 HyperConverged Operator コンポーネント

| コンポーネント | 説明 |

|---|---|

|

|

|

|

|

クラスターから直接ダウンロードできるように、 |

|

| OpenShift Virtualization に必要なすべての Operator、CR、およびオブジェクトが含まれています。 |

|

| Scheduling, Scale, and Performance (SSP) CR。これは、HCO によって自動的に作成されます。 |

|

| Containerized Data Importer (CDI) CR。これは、HCO によって自動的に作成されます。 |

|

|

|

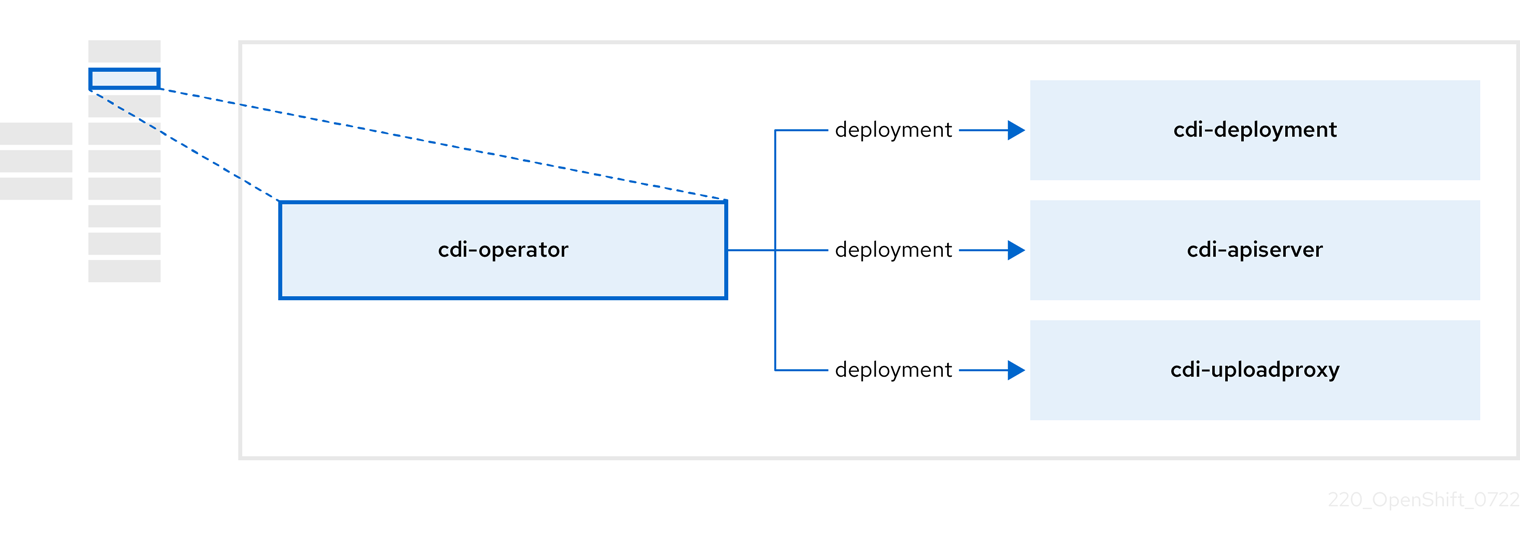

1.3.2. Containerized Data Importer (CDI) Operator について

CDI Operator cdi-operator は、CDI とその関連リソースを管理し、データボリュームを使用して仮想マシンイメージを永続ボリューム要求 (PVC) にインポートします。

表1.8 CDI Operator コンポーネント

| コンポーネント | 説明 |

|---|---|

|

| 安全なアップロードトークンを発行して、VM ディスクを PVC にアップロードするための承認を管理します。 |

|

| 外部ディスクのアップロードトラフィックを適切なアップロードサーバー Pod に転送して、正しい PVC に書き込むことができるようにします。有効なアップロードトークンが必要です。 |

|

| データ ボリュームの作成時に仮想マシンイメージを PVC にインポートするヘルパー Pod。 |

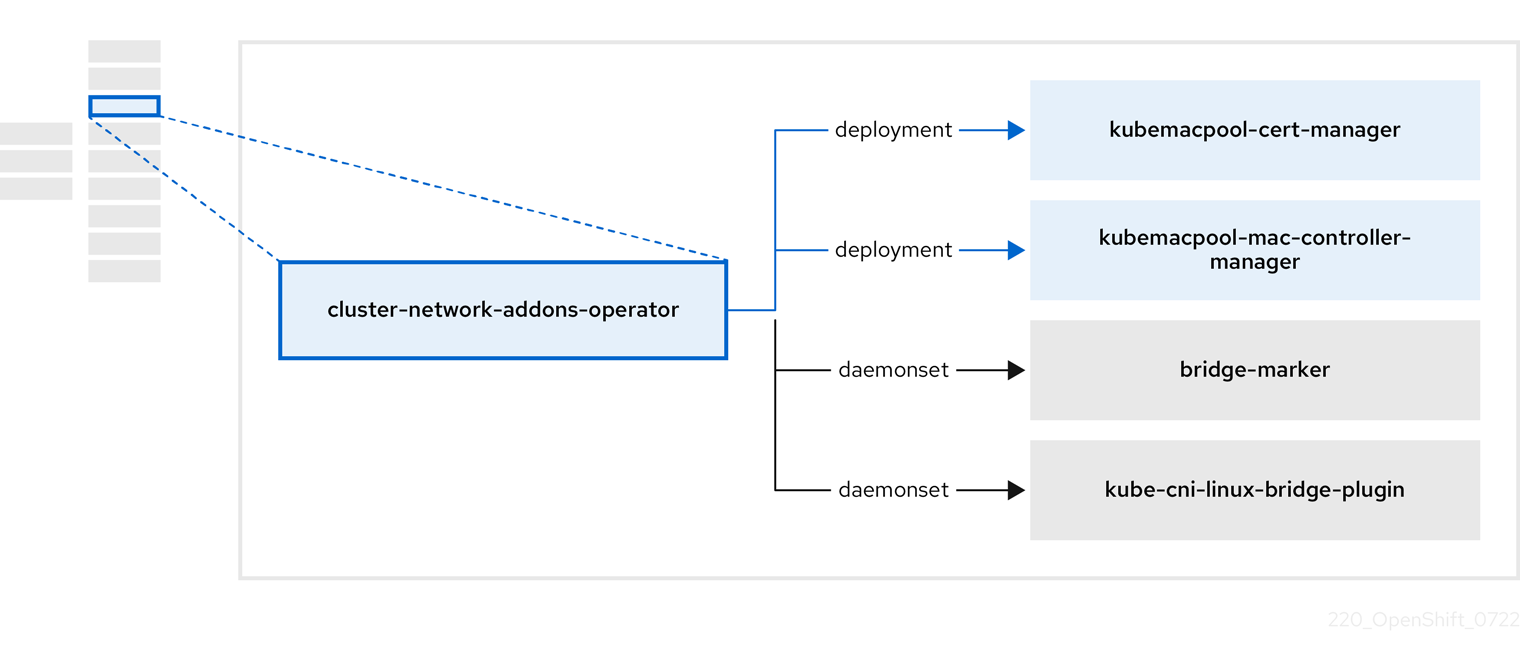

1.3.3. Cluster Network Addons Operator について

Cluster Network Addons Operator (cluster-network-addons-operator) は、クラスターにネットワークコンポーネントをデプロイし、拡張ネットワーク機能の関連リソースを管理します。

表1.9 Cluster Network Addons Operator コンポーネント

| コンポーネント | 説明 |

|---|---|

|

| Kubemacpool の Webhook の TLS 証明書を管理します。 |

|

| 仮想マシン (VM) ネットワークインターフェイス カード (NIC) の MAC アドレスプールサービスを提供します。 |

|

| ノードで使用可能なネットワークブリッジをノードリソースとしてマークします。 |

|

| クラスターノードに Container Network Interface (CNI) プラグインをインストールし、ネットワーク接続定義を介して Linux ブリッジに VM を接続できるようにします。 |

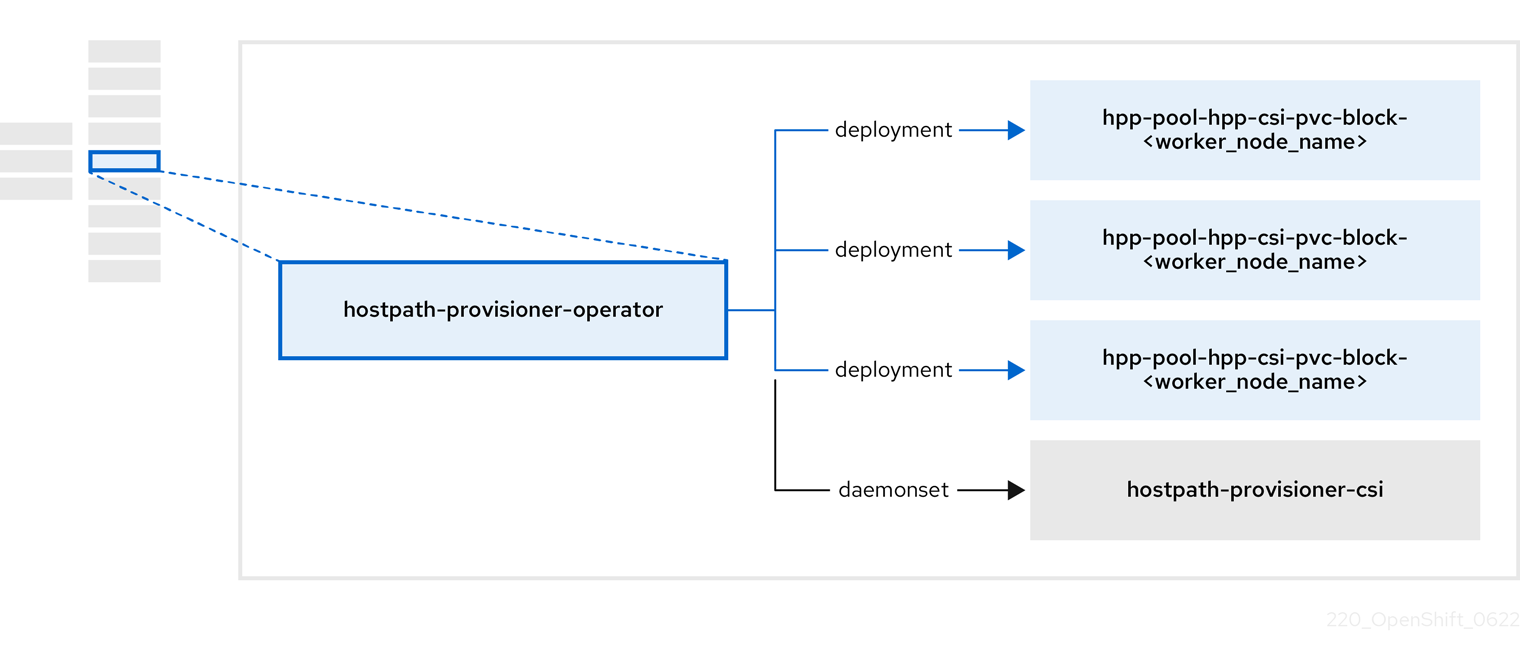

1.3.4. Hostpath Provisioner (HPP) Operator について

HPP オペレーター hostpath-provisioner-operator は、マルチノード HPP および関連リソースをデプロイおよび管理します。

表1.10 HPP Operator コンポーネント

| コンポーネント | 説明 |

|---|---|

|

| HPP の実行が指定されている各ノードにワーカーを提供します。Pod は、指定されたバッキングストレージをノードにマウントします。 |

|

| HPP の Container Storage Interface (CSI) ドライバーインターフェイスを実装します。 |

|

| HPP のレガシードライバーインターフェイスを実装します。 |

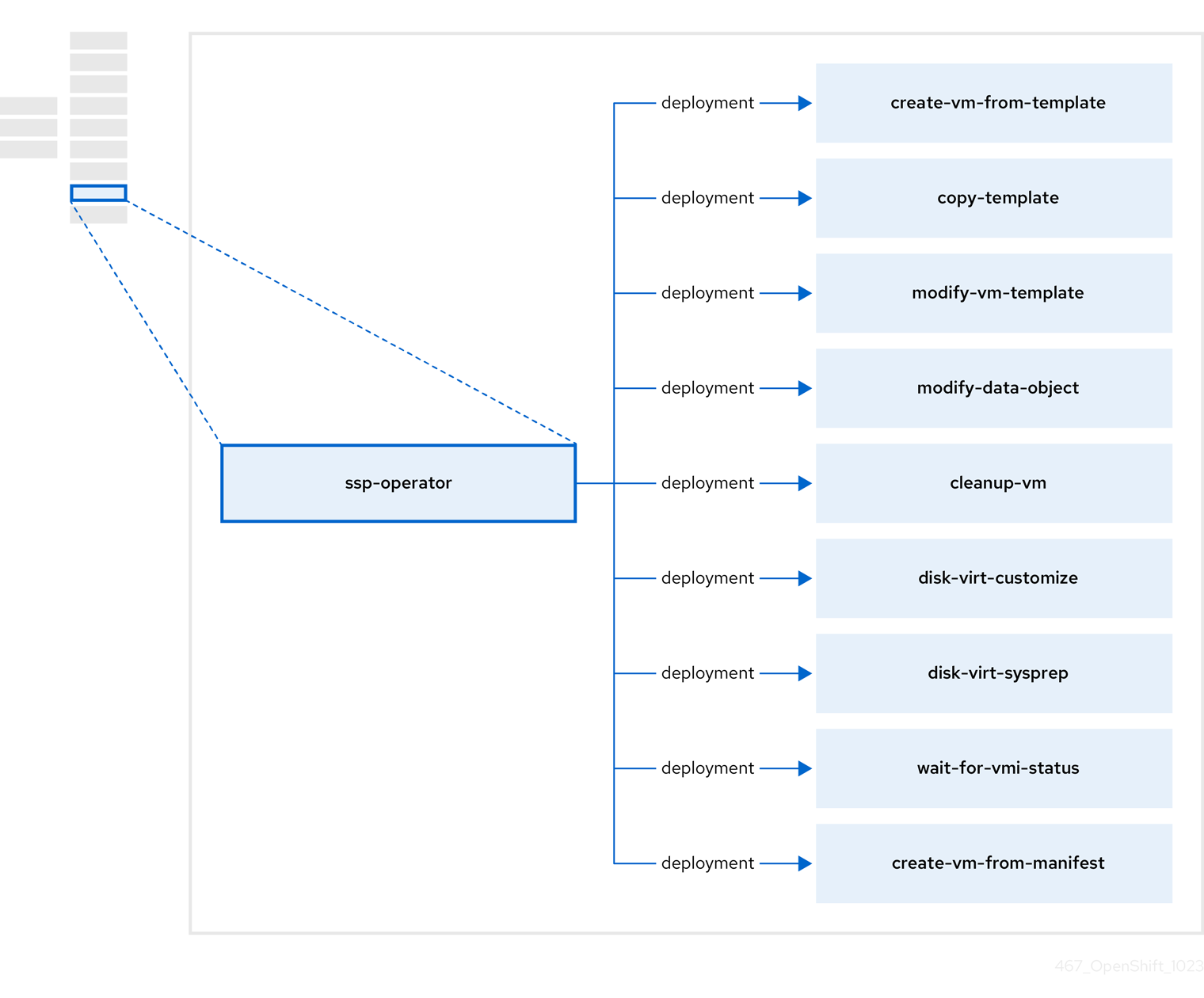

1.3.5. Scheduling, Scale, and Performance (SSP) Operator について

SSP オペレーター ssp-operator は、共通テンプレート、関連するデフォルトのブートソース、パイプラインタスク、およびテンプレートバリデーターをデプロイします。

表1.11 SSP Operator コンポーネント

| コンポーネント | 説明 |

|---|---|

|

| テンプレートから仮想マシンを作成します。 |

|

| 仮想マシンテンプレートをコピーします。 |

|

| 仮想マシンテンプレートを作成または削除します。 |

|

| データボリュームまたはデータソースを作成または削除します。 |

|

| 仮想マシンでスクリプトまたはコマンドを実行し、後で仮想マシンを停止または削除します。 |

|

|

|

|

|

|

|

| 特定の仮想マシンインスタンス (VMI) ステータスを待機し、そのステータスに応じて失敗または成功します。 |

|

| マニフェストから仮想マシンを作成します。 |

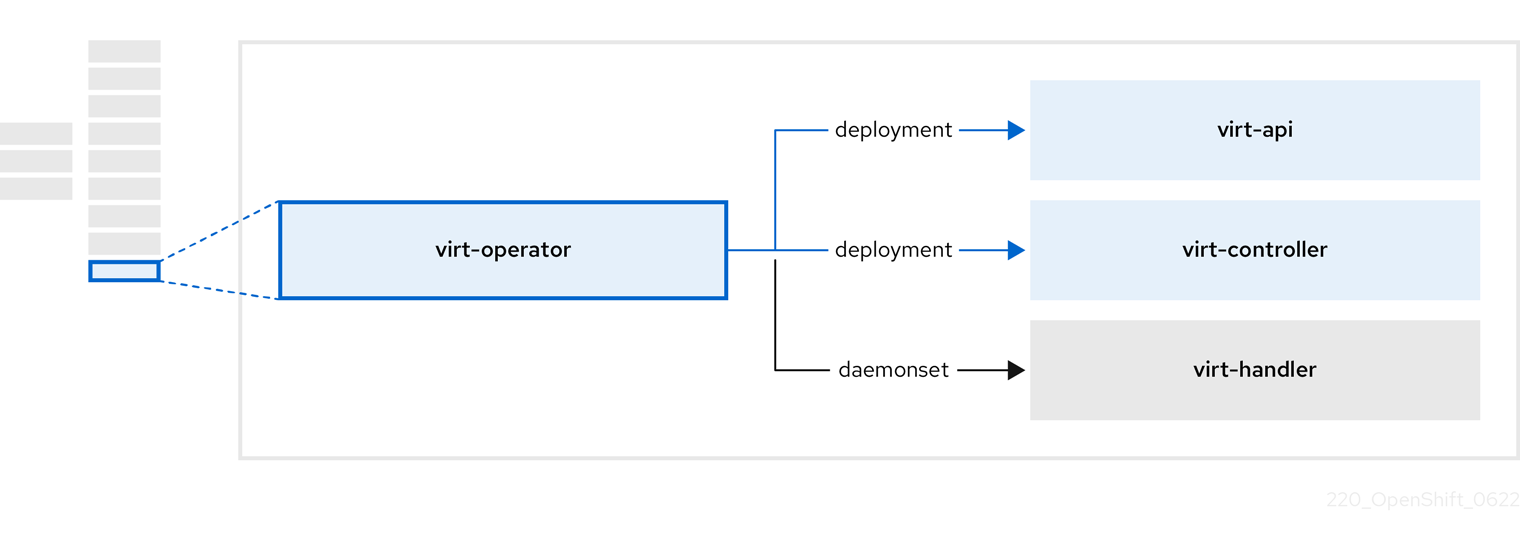

1.3.6. OpenShift Virtualization Operator について

OpenShift Virtualization Operator virt-operator は、現在の仮想マシンワークロードを中断することなく OpenShift Virtualization をデプロイ、アップグレード、管理します。

表1.12 virt-operator コンポーネント

| コンポーネント | 説明 |

|---|---|

|

| すべての仮想化関連フローのエントリーポイントとして機能する HTTP API サーバー。 |

|

|

新しい VM インスタンス オブジェクトの作成を監視し、対応する Pod を作成します。Pod がノードでスケジュールされると、 |

|

|

VM への変更を監視し、必要な操作を実行するように |

|

|

|

第2章 リリースノート

2.1. OpenShift Virtualization リリースノート

2.1.1. 多様性を受け入れるオープンソースの強化

Red Hat では、コード、ドキュメント、Web プロパティーにおける配慮に欠ける用語の置き換えに取り組んでいます。まずは、マスター (master)、スレーブ (slave)、ブラックリスト (blacklist)、ホワイトリスト (whitelist) の 4 つの用語の置き換えから始めます。この取り組みは膨大な作業を要するため、今後の複数のリリースで段階的に用語の置き換えを実施して参ります。詳細は、Red Hat CTO である Chris Wright のメッセージ をご覧ください。

2.1.2. ドキュメントに関するフィードバックの提供

エラーを報告したり、ドキュメントを改善したりするには、Red Hat Jira アカウント にログインし、Jira issue を送信してください。

2.1.3. Red Hat OpenShift Virtualization について

Red Hat OpenShift Virtualization は、従来の仮想マシン (VM) をコンテナーと共に実行される OpenShift Container Platform に組み込み、それらをネイティブ Kubernetes オブジェクトとして管理することを可能にします。

OpenShift Virtualization は、

![]() アイコンで表されます。

アイコンで表されます。

OVN-Kubernetes または OpenShiftSDN のデフォルトの Container Network Interface (CNI) ネットワークプロバイダーのいずれかで OpenShift Virtualization を使用できます。

OpenShift Virtualization の機能 を参照してください。

OpenShift Virtualization のアーキテクチャーとデプロイメント の詳細を参照してください。

OpenShift Virtualization 用に クラスターを準備します。

2.1.3.1. OpenShift Virtualization サポートのクラスターバージョン

OpenShift Virtualization 4.14 は OpenShift Container Platform 4.14 クラスターで使用するためにサポートされます。Open Shift Virtualization の最新の z-stream リリースを使用するには、最初に Open Shift Container Platform の最新バージョンにアップグレードする必要があります。

2.1.3.2. サポート対象のゲストオペレーティングシステム

OpenShift Virtualization でサポートされているゲストオペレーティングシステムを確認するには、Red Hat OpenStack Platform、Red Hat Virtualization、OpenShift Virtualization、Red Hat Enterprise Linux with KVM の認定ゲストオペレーティングシステム を参照してください。

2.1.4. 新機能および変更された機能

OpenShift Virtualization は、Windows Server のワークロードを実行する Microsoft の Windows Server Virtualization Validation Program (SVVP) で認定されています。

SVVP の認定は以下に適用されます。

- Red Hat Enterprise Linux CoreOS ワーカー。Microsoft SVVP Catalog では、Red Hat OpenShift Container Platform 4 on RHEL CoreOS 9 という名前が付けられます。

- Intel および AMD CPU。

- OpenShift Virtualization でホストされたコントロールプレーンクラスターの作成は、以前はテクノロジープレビュー機能でしたが、現在は一般提供されています。詳細は、Red Hat Advanced Cluster Management (RHACM) ドキュメントの OpenShift Virtualization でのホストされたコントロールプレーンクラスターの管理 を参照してください。

Amazon Web Services (AWS) ベアメタル OpenShift Container Platform クラスター上で OpenShift Virtualization を使用することは、以前はテクノロジープレビューでしたが、現在は一般提供されています。

さらに、OpenShift Virtualization が Red Hat OpenShift Service on AWS の Classic クラスターでサポートされるようになりました。

詳細は、AWS ベアメタル上の OpenShift Virtualization を参照してください。

- NVIDIA GPU Operator を使用して GPU 対応仮想マシンのワーカーノードをプロビジョニングすることは、以前はテクノロジープレビューでしたが、現在は一般提供されています。詳細は、NVIDIA GPU Operator の設定 を参照してください。

- クラスター管理者は、OpenShift API for Data Protection (OADP) を使用して、OpenShift Virtualization で実行しているアプリケーションをバックアップおよび復元できます。

- Web コンソールを使用して、静的 の 認可された SSH キー をプロジェクトに追加できます。その後、キーはプロジェクト内で作成したすべての仮想マシンに追加されます。

-

OpenShift Virtualization は、仮想マシンの Persistent Volume Claims (PVC) を使用した、仮想 Trusted Platform Module (vTPM) デバイス状態の永続化をサポートするようになりました。

HyperConvergedカスタムリソース (CR) でvmStateStorageClass属性を設定することにより、PVC が使用する ストレージクラスを指定する 必要があります。

- RHEL 9 仮想マシンに対して 動的 SSH キーインジェクション を有効にできます。その後、実行時に認証された SSH キーを更新できます。

- ブートソースとして ボリュームスナップショットを有効化 できるようになりました。

ストレージプロファイルのアクセスモードとボリュームモードのフィールドには、次の追加の Containerized Storage Interface プロビジョナーに最適な値が自動的に入力されます。

- Dell PowerFlex

- Dell PowerMax

- Dell PowerScale

- Dell Unity

- Dell PowerStore

- Hitachi Virtual Storage Platform

- IBM Fusion Hyper-Converged Infrastructure

- IBM Fusion General Parallel File System

- IBM Fusion Software-Defined Storage

- IBM Fusion ブロックアレイ

- Hewlett Packard Enterprise 3PAR

- Hewlett Packard Enterprise Nimble

- Hewlett Packard Enterprise Alletra

- Hewlett Packard Enterprise Primera

- カスタムスケジューラー を使用して、ノード上の仮想マシンをスケジュールできます。

- データボリュームのガベージコレクションはデフォルトでは無効になっています。

- Web コンソールを使用して、静的 の 認可された SSH キー をプロジェクトに追加できます。その後、キーはプロジェクト内で作成したすべての仮想マシンに追加されます。

次の Runbook が変更されました。

-

SingleStackIPv6UnsupportedおよびVMStorageClassWarningが追加されました。 -

KubeMacPoolDownはKubemacpoolDownに名前が変更になりました。 -

KubevirtHyperconvergedClusterOperatorInstallationNotCompletedAlertはHCOInstallationIncompleteに名前が変更になりました。 -

KubevirtHyperconvergedClusterOperatorCRModificationはKubeVirtCRModifiedに名前が変更になりました。 -

KubevirtHyperconvergedClusterOperatorUSModificationはUnsupportedHCOModificationに名前が変更になりました。 -

SSPOperatorDownはSSPDownに名前が変更になりました。

-

2.1.4.1. クイックスタート

-

クイックスタートツアーは、複数の OpenShift Virtualization 機能で利用できます。ツアーを表示するには、OpenShift Virtualization コンソールのヘッダーのメニューバーにある Help アイコン ? をクリックし、Quick Starts を選択します。Filter フィールドに

virtualizationキーワードを入力して、利用可能なツアーをフィルターできます。

2.1.4.2. ネットワーク

- Web コンソールまたは CLI を使用して、仮想マシンを OVN-Kubernetes セカンダリーネットワーク に接続できます。

2.1.4.3. Web コンソール

- クラスター管理者は、OpenShift Virtualization Web コンソール で Red Hat Enterprise Linux (RHEL) 仮想マシンの自動サブスクリプションを有効にできるようになりました。

- 応答しない仮想マシンを アクションメニュー から強制停止できるようになりました。仮想マシンを強制停止するには、アクションメニューから Stop、Force stop の順に選択します。

- DataSources と Bootable volumes ページが ブート可能ボリューム ページ に統合され、これらの同様のリソースを 1 つの場所で管理できるようになりました。

- クラスター管理者は、Virtualization → Overview ページの Settings タブで テクノロジープレビュー 機能を有効または無効にできます。

- VM の VNC にアクセスするための 一時トークンを生成 できるようになりました。

2.1.5. 非推奨および削除された機能

2.1.5.1. 非推奨の機能

非推奨の機能は現在のリリースに含まれており、サポートされています。ただし、これらは今後のリリースで削除されるため、新規デプロイメントでの使用は推奨されません。

-

tekton-tasks-operatorは非推奨になり、Tekton タスクとサンプルパイプラインはssp-operatorによってデプロイされるようになりました。

-

copy-template、modify-vm-template、およびcreate-vm-from-templateタスクは非推奨になりました。

- OpenShift Virtualization メトリクスの多くが変更されているか、今後のバージョンで変更される予定です。これらの変更はカスタムダッシュボードに影響を与える可能性があります。詳細は、、OpenShift Virtualization 4.14 のメトリクスの変更 を参照してください。(BZ#2179660)

- Windows Server 2012 R2 テンプレートのサポートは廃止されました。

2.1.5.2. 削除された機能

削除された機能は、現在のリリースではサポートされません。

- 従来の HPP カスタムリソースと関連するストレージクラスのサポートは、すべての新しいデプロイメントで削除されました。OpenShift Virtualization 4.14 では、HPP Operator は Kubernetes Container Storage Interface (CSI) ドライバーを使用してローカルストレージを設定します。レガシー HPP カスタムリソースは、以前のバージョンの OpenShift Virtualization にインストールされていた場合にのみサポートされます。

-

virtctlクライアントを RPM としてインストールすることは、Red Hat Enterprise Linux (RHEL) 7 および RHEL 9 ではサポートされなくなりました。

2.1.6. テクノロジープレビューの機能

現在、今回のリリースに含まれる機能にはテクノロジープレビューのものがあります。これらの実験的機能は、実稼働環境での使用を目的としていません。これらの機能に関しては、Red Hat カスタマーポータルの以下のサポート範囲を参照してください。

- カスタマイズされたインスタンスタイプ と設定をインストールおよび編集して、ボリュームまたは PersistentVolumeClaim (PVC) から仮想マシンを作成できるようになりました。

- クラスター全体 の 仮想マシンエビクションストラテジー を設定できるようになりました。

- ブリッジネットワークインターフェイス を実行中の仮想マシン (VM) にホットプラグできます。ホットプラグとホットアンプラグは、OpenShift Virtualization 4.14 以降で作成された仮想マシンでのみサポートされます。

2.1.7. バグ修正

-

HyperConvergedカスタムリソース (CR) の 仲介デバイス設定 API が更新され、一貫性が向上しました。以前はmediatedDevicesTypesという名前であったフィールドは、nodeMediatedDeviceTypesフィールドに使用されている命名規則に合わせてmediatedDeviceTypesという名前になりました。(BZ#2054863)

-

Single Node OpenShift (SNO) クラスター上の共通テンプレートから作成された仮想マシンは、クラスターレベルのエビクションストラテジーが

Noneである場合にVMCannotBeEvictedアラートを表示しなくなりました。(BZ#2092412)

- Windows 11 仮想マシンが、FIPS モード で実行されているクラスター上で起動するようになりました。(BZ#2089301)

- さまざまなコンピュートノードが含まれる異種クラスターで、HyperV Reenlightenment が有効な仮想マシンを、タイムスタンプカウンター (TSC) スケーリングをサポートしていないノードまたは TSC の周波数が不適切なノードでスケジュールできます。(BZ#2151169)

-

異なる SELinux コンテキストを持つ 2 つの Pod を使用しても、

ocs-storagecluster-cephfsストレージクラスを持つ仮想マシンが移行に失敗しなくなりました。(BZ#2092271)

- クラスター上のノードを停止し、Node Health Check Operator を使用してノードを再起動した場合も、Multus への接続が維持されます。(OCPBUGS-8398)

-

バインディングモードが

WaitForFirstConsumerであるストレージの仮想マシンスナップショットを復元しても、復元された PVC がPending状態のままではなくなり、復元操作が続行されます。(BZ#2149654)

2.1.8. 既知の問題

Monitoring

Pod Disruption Budget (PDB) は、移行可能な仮想マシンイメージについての Pod の中断を防ぎます。PDB が Pod の中断を検出する場合、

openshift-monitoringはLiveMigrateエビクションストラテジーを使用する仮想マシンイメージに対して 60 分ごとにPodDisruptionBudgetAtLimitアラートを送信します。(BZ#2026733)- 回避策として、アラートをサイレンス にします。

ネットワーク

OpenShift Container Platform クラスターが OVN-Kubernetes をデフォルトの Container Network Interface (CNI) プロバイダーとして使用する場合、OVN-Kubernetes のホストネットワークトポロジーの変更により、Linux ブリッジまたはボンディングデバイスをホストのデフォルトインターフェイスに割り当てることはできません。(BZ#1885605)

- 回避策として、ホストに接続されたセカンダリーネットワークインターフェイスを使用するか、OpenShift SDN デフォルト CNI プロバイダーに切り替えることができます。

-

install-config.yamlファイルでnetworkType: OVNKubernetesオプションを使用している場合、仮想マシンに SSH 接続することはできません。(BZ#2165895)

- シングルスタックの IPv6 クラスターで OpenShift Virtualization は実行できません。(BZ#2193267)

ノード

-

OpenShift Virtualization をアンインストールしても、OpenShift Virtualization によって作成された

feature.node.kubevirt.ioノードラベルは削除されません。ラベルは手動で削除する必要があります。(CNV-22036)

Storage

場合によっては、複数の仮想マシンが読み取り/書き込みモードで同じ PVC をマウントできるため、データが破損する可能性があります。(BZ#1992753)

- 回避策として、複数の仮想マシンで読み取り/書き込みモードで単一の PVC を使用しないでください。

csi-cloneクローンストラテジーを使用して 100 台以上の仮想マシンのクローンを作成する場合、Ceph CSI はクローンをパージしない可能性があります。クローンの手動削除も失敗する可能性があります。(BZ#2055595)-

回避策として、

ceph-mgrを再起動して仮想マシンのクローンをパージすることができます。

-

回避策として、

AWS 上のストレージソリューションとして Portworx を使用し、仮想マシンのディスクイメージを作成する場合、ファイルシステムのオーバーヘッドが 2 回考慮されるため、作成されるイメージは予想よりも小さくなる可能性があります。(BZ#2237287)

- 回避策として、最初のプロビジョニングプロセスの完了後に永続ボリューム要求 (PVC) を手動で拡張して、利用可能なスペースを増やすことができます。

openshift-virtualization-os-imagesnamespace で提供された DataSource を使用して 1000 台を超える仮想マシンを同時にクローン作成する場合、一部の仮想マシンが実行状態に遷移しない可能性があります。(BZ#2216038)- 回避策として、仮想マシンを小さなバッチに分けてデプロイします。

- ホットプラグボリュームを追加または削除した後は、仮想マシンインスタンス (VMI) に対してライブマイグレーションを有効にできません。(BZ#2247593)

仮想化

OpenShift Virtualization は、Pod によって使用されるサービスアカウントトークンをその特定の Pod にリンクします。OpenShift Virtualization は、トークンが含まれるディスクイメージを作成してサービスアカウントボリュームを実装します。仮想マシンを移行すると、サービスアカウントボリュームが無効になります。(BZ#2037611)

- 回避策として、サービスアカウントではなくユーザーアカウントを使用してください。ユーザーアカウントトークンは特定の Pod にバインドされていないためです。

RHSA-2023:3722 アドバイザリーのリリースにより、FIPS 対応 RHEL 9 システム上の TLS 1.2 接続に、TLS

Extended Master Secret(EMS) エクステンション (RFC 7627) エクステンションが必須になりました。これは FIPS-140-3 要件に準拠しています。TLS 1.3 は影響を受けません。(BZ#2157951)EMS または TLS 1.3 をサポートしていないレガシー OpenSSL クライアントは、RHEL 9 で実行されている FIPS サーバーに接続できなくなりました。同様に、FIPS モードの RHEL 9 クライアントは、EMS なしでは TLS 1.2 のみをサポートするサーバーに接続できません。これは実際には、これらのクライアントが RHEL 6、RHEL 7、および RHEL 以外のレガシーオペレーティングシステム上のサーバーに接続できないことを意味します。これは、OpenSSL のレガシー 1.0.x バージョンが EMS または TLS 1.3 をサポートしていないためです。詳細は、TLS Extension "Extended Master Secret" enforced with Red Hat Enterprise Linux 9.2 を参照してください。

回避策として、レガシー OpenSSL クライアントを TLS 1.3 をサポートするバージョンにアップグレードし、FIPS モードで

最新のTLS セキュリティープロファイルタイプで TLS 1.3 を使用するように OpenShift Virtualization を設定します。

Web コンソール

OpenShift Virtualization をアップグレードせずに OpenShift Container Platform 4.13 を 4.14 にアップグレードすると、Web コンソールの Virtualization ページがクラッシュします。(OCPBUGS-22853)

OpenShift Virtualization Operator を手動で 4.14 にアップグレードするか、サブスクリプション承認ストラテジーを "Automatic" に設定する必要があります。

第3章 スタートガイド

3.1. OpenShift Virtualization の開始

基本的な環境をインストールして設定することにより、OpenShift Virtualization の特徴と機能を調べることができます。

クラスター設定手順には、cluster-admin 権限が必要です。

3.1.1. OpenShift Virtualization の計画とインストール

OpenShift Container Platform クラスターで OpenShift Virtualization を計画およびインストールします。

計画およびインストールのリソース

3.1.2. 仮想マシンの作成と管理

仮想マシンを作成します。

Red Hat テンプレートまたはインスタンスタイプを使用して仮想マシンを作成できます。

カスタムチューニング仕様のカスタムプロファイルはテクノロジープレビュー機能としてのみご利用いただけます。テクノロジープレビュー機能は、Red Hat 製品サポートのサービスレベルアグリーメント (SLA) の対象外であり、機能的に完全ではない場合があります。Red Hat は、実稼働環境でこれらを使用することを推奨していません。テクノロジープレビューの機能は、最新の製品機能をいち早く提供して、開発段階で機能のテストを行いフィードバックを提供していただくことを目的としています。

Red Hat のテクノロジープレビュー機能のサポート範囲に関する詳細は、テクノロジープレビュー機能のサポート範囲 を参照してください。

仮想マシンを作成するには、コンテナーレジストリーまたは Web ページからカスタムイメージをインポートするか、ローカルマシンからイメージをアップロードするか、永続ボリューム要求 (PVC) を複製することによって実行できます。

仮想マシンをセカンダリーネットワークに接続します。

- Linux ブリッジネットワーク。

- オープン仮想ネットワーク (OVN)- Kubernetes セカンダリーネットワーク。

シングルルート I/O 仮想化 (SR-IOV) ネットワーク。

注記VM はデフォルトで Pod ネットワークに接続されます。

仮想マシンに接続します。

- 仮想マシンの シリアルコンソール または VNC コンソール に接続します。

- SSH を使用して仮想マシンに接続します。

- Windows 仮想マシンのデスクトップビューアーに接続します。

仮想マシンを管理します。

3.1.3. 次のステップ

3.2. virtctl および libguestfs CLI ツールの使用

virtctl コマンドラインツールを使用して、OpenShift Virtualization リソースを管理できます。

libguestfs コマンドラインツールを使用すると、仮想マシンのディスクイメージにアクセスして変更できます。libguestfs をデプロイするには、virtctl libguestfs コマンドを使用します。

3.2.1. virtctl のインストール

Red Hat Enterprise Linux (RHEL) 9、Linux、Windows、および MacOS オペレーティングシステムに virtctl をインストールするには、virtctl バイナリーファイルをダウンロードしてインストールします。

RHEL 8 に virtctl をインストールするには、OpenShift Virtualization リポジトリーを有効にしてから、kubevirt-virtctl パッケージをインストールします。

3.2.1.1. RHEL 9、Linux、Windows、 macOS への virtctl バイナリーのインストール

OpenShift Container Platform Web コンソールからオペレーティングシステムの virtctl バイナリーをダウンロードし、それをインストールできます。

手順

- Web コンソールの Virtualization → Overview ページに移動します。

-

Download virtctl リンクをクリックして、オペレーティングシステム用の

virtctlバイナリーをダウンロードします。 virtctlをインストールします。RHEL 9 およびその他の Linux オペレーティングシステムの場合:

アーカイブファイルを解凍します。

$ tar -xvf <virtctl-version-distribution.arch>.tar.gz

次のコマンドを実行して、

virtctlバイナリーを実行可能にします。$ chmod +x <path/virtctl-file-name>

virtctlバイナリーをPATH 環境変数にあるディレクトリーに移動します。次のコマンドを実行して、パスを確認できます。

$ echo $PATH

KUBECONFIG環境変数を設定します。$ export KUBECONFIG=/home/<user>/clusters/current/auth/kubeconfig

Windows の場合:

- アーカイブファイルを解凍します。

-

展開したフォルダー階層に移動し、

virtctl実行可能ファイルをダブルクリックしてクライアントをインストールします。 virtctlバイナリーをPATH 環境変数にあるディレクトリーに移動します。次のコマンドを実行して、パスを確認できます。

C:\> path

MacOS の場合:

- アーカイブファイルを解凍します。

virtctlバイナリーをPATH 環境変数にあるディレクトリーに移動します。次のコマンドを実行して、パスを確認できます。

echo $PATH

3.2.1.2. RHEL 8 への virtctl RPM のインストール

OpenShift Virtualization リポジトリーを有効にし、kubevirt-virtctl パッケージをインストールすることで、Red Hat Enterprise Linux (RHEL) 8 に virtctl RPM をインストールできます。

前提条件

- クラスター内の各ホストは Red Hat Subscription Manager (RHSM) に登録されており、アクティブな OpenShift Container Platform サブスクリプションを持つ必要があります。

手順

subscription-managerCLI ツールを使用して次のコマンドを実行し、OpenShift Virtualization リポジトリーを有効にします。# subscription-manager repos --enable cnv-4.14-for-rhel-8-x86_64-rpms

次のコマンドを実行して、

kubevirt-virtctlパッケージをインストールします。# yum install kubevirt-virtctl

3.2.2. virtctl コマンド

virtctl クライアントは、OpenShift Virtualization リソースを管理するためのコマンドラインユーティリティーです。

特に指定がない限り、仮想マシンコマンドは仮想マシンインスタンスにも適用されます。

3.2.2.1. virtctl 情報コマンド

virtctl information コマンドを使用して、virtctl クライアントに関する情報を表示します。

表3.1 情報コマンド

| コマンド | 説明 |

|---|---|

|

|

|

|

|

|

|

| 特定のコマンドのオプションのリストを表示します。 |

|

|

任意の |

3.2.2.2. 仮想マシン情報コマンド

virtctl を使用すると、仮想マシンおよび仮想マシンインスタンス (VMI) に関する情報を表示できます。

表3.2 仮想マシン情報コマンド

| コマンド | 説明 |

|---|---|

|

| ゲストマシンで使用可能なファイルシステムを表示します。 |

|

| ゲストマシンのオペレーティングシステムに関する情報を表示します。 |

|

| ゲストマシンにログインしているユーザーを表示します。 |

3.2.2.3. 仮想マシン管理コマンド

virtctl 仮想マシン管理コマンドを使用して、仮想マシンおよび仮想マシンインスタンスを管理および移行します。

表3.3 仮想マシン管理コマンド

| コマンド | 説明 |

|---|---|

|

|

|

|

| 仮想マシンを開始します。 |

|

| 仮想マシンを一時停止状態で起動します。このオプションを使用すると、VNC コンソールからブートプロセスを中断できます。 |

|

| 仮想マシンを停止します。 |

|

| 仮想マシンを強制停止します。このオプションは、データの不整合またはデータ損失を引き起こす可能性があります。 |

|

| 仮想マシンを一時停止します。マシンの状態がメモリーに保持されます。 |

|

| 仮想マシンの一時停止を解除します。 |

|

| 仮想マシンを移行します。 |

|

| 仮想マシンの移行をキャンセルします。 |

|

| 仮想マシンを再起動します。 |

|

|

|

|

|

|

3.2.2.4. 仮想マシン接続コマンド

virtctl 接続コマンドを使用してポートを公開し、仮想マシンおよび仮想マシンインスタンスに接続します。

表3.4 仮想マシン接続コマンド

| コマンド | 説明 |

|---|---|

|

| 仮想マシンのシリアルコンソールに接続します。 |

|

| 仮想マシンの指定されたポートを転送するサービスを作成し、ノードの指定されたポートでサービスを公開します。

例: |

|

| マシンから仮想マシンにファイルをコピーします。このコマンドは、SSH キーペアの秘密キーを使用します。仮想マシンは公開キーを使用して設定する必要があります。 |

|

| 仮想マシンからマシンにファイルをコピーします。このコマンドは、SSH キーペアの秘密キーを使用します。仮想マシンは公開キーを使用して設定する必要があります。 |

|

| 仮想マシンとの SSH 接続を開きます。このコマンドは、SSH キーペアの秘密キーを使用します。仮想マシンは公開キーを使用して設定する必要があります。 |

|

| 仮想マシンの VNC コンソールに接続します。

|

|

| ポート番号を表示し、VNC 接続を介してビューアーを使用して手動で VM に接続します。 |

|

| ポートが利用可能な場合、その指定されたポートでプロキシーを実行するためにポート番号を指定します。 ポート番号が指定されていない場合、プロキシーはランダムポートで実行されます。 |

3.2.2.5. 仮想マシンエクスポートコマンド

virtctl vmexport コマンドを使用して、仮想マシン、仮想マシンスナップショット、または永続ボリューム要求 (PVC) からエクスポートされたボリュームを作成、ダウンロード、または削除できます。特定のマニフェストには、OpenShift Virtualization が使用できる形式でディスクイメージをインポートするためのエンドポイントへのアクセスを許可するヘッダーシークレットも含まれています。

表3.5 仮想マシンエクスポートコマンド

| コマンド | 説明 |

|---|---|

|

|

仮想マシン、仮想マシンスナップショット、または PVC からボリュームをエクスポートするには、

|

|

|

|

|

|

オプション:

|

|

|

|

|

| 既存のエクスポートのマニフェストを取得します。マニフェストにはヘッダーシークレットが含まれていません。 |

|

| 仮想マシンサンプルの仮想マシンエクスポートを作成し、マニフェストを取得します。マニフェストにはヘッダーシークレットが含まれていません。 |

|

| 仮想マシンスナップショットの例の仮想マシンエクスポートを作成し、マニフェストを取得します。マニフェストにはヘッダーシークレットが含まれていません。 |

|

| 既存のエクスポートのマニフェストを取得します。マニフェストにはヘッダーシークレットが含まれています。 |

|

| 既存のエクスポートのマニフェストを json 形式で取得します。マニフェストにはヘッダーシークレットが含まれていません。 |

|

| 既存のエクスポートのマニフェストを取得します。マニフェストにはヘッダーシークレットが含まれており、指定されたファイルにそれを書き込みます。 |

3.2.2.6. 仮想マシンメモリーダンプコマンド

virtctl memory-dump コマンドを使用して、PVC に仮想マシンのメモリーダンプを出力できます。既存の PVC を指定するか、--create-claim フラグを使用して新しい PVC を作成できます。

前提条件

-

PVC ボリュームモードは

FileSystemである必要があります。 PVC は、メモリーダンプを格納するのに十分な大きさである必要があります。

PVC サイズを計算する式は

(VMMemorySize + 100Mi) * FileSystemOverheadです。ここで、100Miはメモリーダンプのオーバーヘッドです。次のコマンドを実行して、

HyperConvergedカスタムリソースでホットプラグフィーチャーゲートを有効にする必要があります。$ oc patch hyperconverged kubevirt-hyperconverged -n openshift-cnv \ --type json -p '[{"op": "add", "path": "/spec/featureGates", \ "value": "HotplugVolumes"}]'

メモリーダンプのダウンロード

メモリーダンプをダウンロードするには、virtctl vmexport download コマンドを使用する必要があります。

$ virtctl vmexport download <vmexport_name> --vm|pvc=<object_name> \ --volume=<volume_name> --output=<output_file>

表3.6 仮想マシンメモリーダンプコマンド

| コマンド | 説明 |

|---|---|

|

|

仮想マシンのメモリーダンプを PVC に保存します。メモリーダンプのステータスは、 オプション:

|

|

|

同じ PVC で このコマンドは、以前のメモリーダンプを上書きします。 |

|

| メモリーダンプを削除します。 ターゲット PVC を変更する場合は、メモリーダンプを手動で削除する必要があります。

このコマンドは、 |

3.2.2.7. ホットプラグおよびホットアンプラグコマンド

virtctl を使用して、実行中の仮想マシンおよび仮想マシンインスタンス (VMI) にリソースを追加または削除します。

表3.7 ホットプラグおよびホットアンプラグコマンド

| コマンド | 説明 |

|---|---|

|

| データボリュームまたは永続ボリューム要求 (PVC) をホットプラグします。 オプション:

|

|

| 仮想ディスクをホットアンプラグします。 |

|

| Linux ブリッジネットワークインターフェイスをホットプラグします。 |

|

| Linux ブリッジネットワークインターフェイスをホットアンプラグします。 |

3.2.2.8. イメージアップロードコマンド

virtctl image-upload コマンドを使用して、VM イメージをデータボリュームにアップロードできます。

表3.8 イメージアップロードコマンド

| コマンド | 説明 |

|---|---|

|

| VM イメージを既存のデータボリュームにアップロードします。 |

|

| 指定された要求されたサイズの新しいデータボリュームに VM イメージをアップロードします。 |

3.2.3. virtctl を使用した libguestfs のデプロイ

virtctl guestfs コマンドを使用して、libguestfs-tools および永続ボリューム要求 (PVC) がアタッチされた対話型コンテナーをデプロイできます。

手順

libguestfs-toolsでコンテナーをデプロイして PVC をマウントし、シェルを割り当てるには、以下のコマンドを実行します。$ virtctl guestfs -n <namespace> <pvc_name> 1- 1

- PVC 名は必須の引数です。この引数を追加しないと、エラーメッセージが表示されます。

3.2.3.1. Libguestfs および virtctl guestfs コマンド

Libguestfs ツールは、仮想マシン (VM) のディスクイメージにアクセスして変更するのに役立ちます。libguestfs ツールを使用して、ゲスト内のファイルの表示および編集、仮想マシンのクローンおよびビルド、およびディスクのフォーマットおよびサイズ変更を実行できます。

virtctl guestfs コマンドおよびそのサブコマンドを使用して、PVC で仮想マシンディスクを変更して検査し、デバッグすることもできます。使用可能なサブコマンドの完全なリストを表示するには、コマンドラインで virt- と入力して Tab を押します。以下に例を示します。

| コマンド | 説明 |

|---|---|

|

| ターミナルでファイルを対話的に編集します。 |

|

| ゲストに ssh キーを挿入し、ログインを作成します。 |

|

| 仮想マシンによって使用されるディスク容量を確認します。 |

|

| 詳細のリストを含む出力ファイルを作成して、ゲストにインストールされたすべての RPM の詳細リストを参照してください。 |

|

|

ターミナルで |

|

| テンプレートとして使用する仮想マシンディスクイメージをシールします。 |

デフォルトでは、virtctl guestfs は、仮想ディスク管理に必要な項目を含めてセッションを作成します。ただし、動作をカスタマイズできるように、コマンドは複数のフラグオプションもサポートしています。

| フラグオプション | 説明 |

|---|---|

|

|

|

|

| 特定の namespace から PVC を使用します。

|

|

|

|

|

|

デフォルトでは、

クラスターに

設定されていない場合、 |

|

|

|

このコマンドは、PVC が別の Pod によって使用されているかどうかを確認します。使用されている場合には、エラーメッセージが表示されます。ただし、libguestfs-tools プロセスが開始されると、設定では同じ PVC を使用する新規 Pod を回避できません。同じ PVC にアクセスする仮想マシンを起動する前に、アクティブな virtctl guestfs Pod がないことを確認する必要があります。

virtctl guestfs コマンドは、インタラクティブな Pod に割り当てられている PVC 1 つだけを受け入れます。

3.3. Web コンソールの概要

OpenShift Container Platform Web コンソールの Virtualization セクションには、OpenShift Virtualization 環境を管理および監視するための以下のページが含まれています。

表3.9 Virtualization ページ

| ページ | 説明 |

|---|---|

| OpenShift Virtualization 環境を管理および監視します。 | |

| テンプレートのカタログから仮想マシンを作成します。 | |

| 仮想マシンを作成および管理します。 | |

| テンプレートを作成および管理します。 | |

| 仮想マシンのインスタンスタイプを作成および管理します。 | |

| 仮想マシンの設定を作成および管理します。 | |

| ブート可能ボリュームのデータソースを作成および管理します。 | |

| ワークロードの移行ポリシーを作成および管理します。 |

表3.10 キー

| アイコン | 説明 |

|---|---|

|

| Edit アイコン |

|

| Link アイコン |

3.3.1. Overview ページ

Overview ページには、リソース、メトリクス、移行の進行状況、およびクラスターレベルの設定が表示されます。

例3.1 Overview ページ

| 要素 | 説明 |

|---|---|

|

virtctl のダウンロード |

リソースを管理するには、 |

| リソース、使用率、アラート、およびステータス。 | |

| CPU、メモリー、およびストレージリソースのトップコンシューマー。 | |

| ライブマイグレーションのステータス。 | |

| Settings タブには Cluster タブと User タブが含まれています。 | |

| Settings → Cluster タブ | OpenShift Virtualization のバージョン、更新ステータス、ライブマイグレーション、テンプレートプロジェクト、プレビュー機能、ロードバランサーサービス設定。 |

| Settings → User タブ | 承認された SSH キー、ユーザー権限、ウェルカム情報の設定。 |

3.3.1.1. Overview タブ

Overview タブには、リソース、使用率、アラート、およびステータスが表示されます。

例3.2 Overview タブ

| 要素 | 説明 |

|---|---|

| Getting started resources カード |

|

| Memory タイル | 過去 7 日間の傾向を示すグラフを含むメモリー使用率。 |

| Storage タイル | 過去 7 日間の傾向を示すグラフを含むストレージ使用率。 |

| VirtualMachines タイル | 過去 7 日間の傾向を示すグラフを含む仮想マシンの数。 |

| vCPU usage タイル | 過去 7 日間の傾向を示すグラフを含む vCPU 使用率。 |

| VirtualMachine statuses タイル | ステータスごとにグループ化された仮想マシンの数。 |

| Alerts タイル | 重大度別にグループ化された OpenShift Virtualization アラート。 |

| VirtualMachines per resource グラフ | テンプレートとインスタンスタイプから作成された仮想マシンの数。 |

3.3.1.2. Top consumers タブ

Top consumers タブには、CPU、メモリー、およびストレージのトップコンシューマーが表示されます。

例3.3 Top consumers タブ

| 要素 | 説明 |

|---|---|

|

仮想化ダッシュボードを表示 | OpenShift Virtualization のトップコンシューマーを表示する Observe → Dashboards へのリンク。 |

| Time period リスト | 結果をフィルタリングする期間を選択します。 |

| Top consumers リスト | 結果をフィルタリングするトップコンシューマーの数を選択します。 |

| CPU チャート | CPU 使用率が最も高い仮想マシン。 |

| Memory チャート | メモリー使用量が最も多い仮想マシン。 |

| Memory swap traffic チャート | メモリースワップトラフィックが最も多い仮想マシン。 |

| vCPU wait チャート | vCPU 待機時間が最も長い仮想マシン。 |

| Storage throughput チャート | ストレージスループットの使用率が最も高い仮想マシン。 |

| Storage IOPS チャート | 1 秒あたりのストレージ入出力操作の使用率が最も高い仮想マシン。 |

3.3.1.3. Migrations タブ

Migrations タブには、仮想マシンの移行のステータスが表示されます。

例3.4 Migrations タブ

| 要素 | 説明 |

|---|---|

| Time period リスト | 仮想マシンの移行をフィルタリングする期間を選択します。 |

| VirtualMachineInstanceMigrations 情報 テーブル | 仮想マシンの移行のリスト。 |

3.3.1.4. Settings タブ

Settings タブには、クラスター全体の設定が表示されます。

例3.5 Settings タブのタブ

| タブ | 説明 |

|---|---|

| OpenShift Virtualization のバージョンと更新ステータス、ライブマイグレーション、テンプレートプロジェクト、プレビュー機能、ロードバランサーサービス設定。 | |

| 承認された SSH キー管理、ユーザー権限、ウェルカム情報設定。 |

3.3.1.4.1. クラスタータブ

Cluster タブには、OpenShift Virtualization のバージョンと更新ステータスが表示されます。Cluster タブでは、プレビュー機能、ライブマイグレーション、およびその他の設定を設定します。

例3.6 Cluster タブ

| 要素 | 説明 |

|---|---|

| インストール済みバージョン | OpenShift Virtualization バージョン |

| 更新ステータス | OpenShift 仮想化の更新ステータス。 |

| Channel | OpenShift 仮想化の更新チャネル。 |

| Preview features セクション | プレビュー機能 を管理するには、このセクションをデプロイメントします。 プレビュー機能はデフォルトで無効になっているため、運用環境では有効にしないでください。 |

| Live Migration セクション | このセクションを展開して、ライブマイグレーション設定を設定します。 |

| Live Migration → Max. migrations per cluster フィールド | クラスターごとのライブマイグレーションの最大数を選択します。 |

| Live Migration → Max. migrations per node フィールド | ノードごとのライブマイグレーションの最大数を選択します。 |

| Live Migration → Live migration network リスト | ライブマイグレーション専用のセカンダリーネットワークを選択します。 |

| 新しい RHEL VirtualMachines の自動サブスクリプション セクション | Red Hat Enterprise Linux (RHEL) 仮想マシンの自動サブスクリプションを有効にするには、このセクションをデプロイメントします。 この機能を有効にするには、クラスター管理者のパーミッション、組織 ID、およびアクティベーションキーが必要です。 |

| LoadBalancer セクション | このセクションを展開して、仮想マシンへの SSH アクセス用のロードバランサーサービスの作成を有効にします。 クラスターにはロードバランサーが設定されている必要があります。 |

| Template project セクション |

このセクションを展開して、Red Hat テンプレートのプロジェクトを選択します。デフォルトのプロジェクトは Red Hat テンプレートを複数のプロジェクトに保存するには、テンプレートを複製 し、複製したテンプレートのプロジェクトを選択します。 |

3.3.1.4.2. ユーザータブ

User タブでは、ユーザー権限を表示し、承認された SSH キーとウェルカム情報を管理します。

例3.7 User タブ

| 要素 | 説明 |

|---|---|

| Manage SSH keys セクション | このセクションを展開して、認可された SSH キーをプロジェクトに追加します。 キーは、選択したプロジェクトでその後作成するすべての仮想マシンに自動的に追加されます。 |

| Permissions セクション | このセクションをデプロイメントすると、クラスター全体のユーザー権限が表示されます。 |

| ようこそ情報 セクション | このセクションを展開すると、Welcome information ダイアログが表示または非表示になります。 |

3.3.2. Catalog ページ

Catalog ページのテンプレートまたはインスタンスタイプから仮想マシンを作成します。

例3.8 Catalog ページ

| 要素 | 説明 |

|---|---|

| 仮想マシンを作成するためのテンプレートのカタログを表示します。 | |

| 仮想マシンを作成するための起動可能なボリュームとインスタンスのタイプを表示します。 |

3.3.2.1. Template catalog タブ

Template catalog タブでテンプレートを選択して、仮想マシンを作成します。

例3.9 Template catalog タブ

| 要素 | 説明 |

|---|---|

| Template project リスト | Red Hat テンプレートが存在するプロジェクトを選択します。

デフォルトでは、Red Hat テンプレートは |

| All items|Default templates | All items をクリックして、使用可能なすべてのテンプレートを表示します。 |

| Boot source available チェックボックス | チェックボックスをオンにして、使用可能なブートソースを含むテンプレートを表示します。 |

| Operating system チェックボックス | チェックボックスをオンにして、選択したオペレーティングシステムのテンプレートを表示します。 |

| Workload チェックボックス | チェックボックスをオンにして、選択したワークロードを含むテンプレートを表示します。 |

| Search フィールド | テンプレートをキーワードで検索します。 |

| テンプレートタイル | テンプレートタイルをクリックして、テンプレートの詳細を表示し、仮想マシンを作成します。 |

3.3.2.2. InstanceTypes タブ

InstanceTypes タブのインスタンスタイプから仮想マシンを作成します。

インスタンスタイプからの仮想マシンの作成は、テクノロジープレビュー機能のみです。テクノロジープレビュー機能は、Red Hat 製品サポートのサービスレベルアグリーメント (SLA) の対象外であり、機能的に完全ではない場合があります。Red Hat は、実稼働環境でこれらを使用することを推奨していません。テクノロジープレビューの機能は、最新の製品機能をいち早く提供して、開発段階で機能のテストを行いフィードバックを提供していただくことを目的としています。

Red Hat のテクノロジープレビュー機能のサポート範囲に関する詳細は、テクノロジープレビュー機能のサポート範囲 を参照してください。

| 要素 | 説明 |

|---|---|

| Volumes project フィールド |

ブート可能なボリュームが保存されているプロジェクト。デフォルトは |

| Add volume ボタン | クリックして新しいボリュームをアップロードするか、既存の永続ボリューム要求を使用します。 |

| Filter フィールド | オペレーティングシステムまたはリソースごとにブートソースをフィルタリングします。 |

| Search フィールド | ブートソースを名前で検索します。 |

| Manage columns アイコン | テーブルに表示する列を最大 9 つ選択します。 |

| ボリュームテーブル | 仮想マシンのブート可能ボリュームを選択します。 |

| Red Hat provided タブ | Red Hat が提供するインスタンスタイプを選択します。 |

| User provided タブ | InstanceType ページで作成したインスタンスタイプを選択します。 |

| VirtualMachine details ペイン | 仮想マシンの設定を表示します。 |

| Name フィールド | オプション: 仮想マシン名を入力します。 |

| SSH キーの名前 | 編集アイコンをクリックして公開 SSH キーを追加します。 |

| 作成後にこの VirtualMachine を開始する チェックボックス | 仮想マシンが自動的に起動しないようにするには、このチェックボックスをオフにします。 |

| Create VirtualMachine ボタン | 仮想マシンを作成します。 |

| YAML & CLI ボタン |

YAML 設定ファイルと、コマンドラインから仮想マシンを作成するための |

3.3.3. VirtualMachines ページ

VirtualMachines ページで仮想マシンを作成および管理します。

例3.10 VirtualMachines ページ

| 要素 | 説明 |

|---|---|

| Create ボタン | テンプレート、ボリューム、または YAML 設定ファイルから仮想マシンを作成します。 |

| Filter フィールド | ステータス、テンプレート、オペレーティングシステム、またはノードで仮想マシンをフィルタリングします。 |

| Search フィールド | 仮想マシンを名前またはラベルで検索します。 |

| Manage columns アイコン | テーブルに表示する列を最大 9 つ選択します。Namespace 列は、Projects リストから All Projects が選択されている場合にのみ表示されます。 |

| 仮想マシンテーブル | 仮想マシンのリスト。

仮想マシンの横にあるアクションメニュー

仮想マシンをクリックして、VirtualMachine details ページに移動します。 |

3.3.3.1. VirtualMachine details ページ

VirtualMachine details ページで仮想マシンを設定します。

例3.11 VirtualMachine details ページ

| 要素 | 説明 |

|---|---|

| Actions メニュー | Actions メニューをクリックして、Stop、Restart、Pause、Clone、Migrate、Copy SSH command、Edit labels、Edit annotations、または Delete を選択します。Stop を選択すると、、アクションメニューの Force stop が Stop に置き換わります。オペレーティングシステムが応答しなくなった場合は、Force stop を使用して即時シャットダウンを開始します。 |

| リソースの使用率、アラート、ディスク、およびデバイス。 | |

| 仮想マシンの詳細と設定。 | |

| メモリー、CPU、ストレージ、ネットワーク、移行のメトリクス。 | |

| 仮想マシンの YAML 設定ファイル。 | |

| Disks、Network interfaces、Scheduling、Environment、および Scripts タブが含まれます。 | |

| ディスク。 | |

| ネットワークインターフェイス。 | |

| 特定のノードで実行するように仮想マシンをスケジュールする | |

| 設定マップ、シークレット、およびサービスアカウントの管理。 | |

| Linux 仮想マシンの Cloud-init 設定、承認された SSH キーと動的キーインジェクション、Windows 仮想マシンの Sysprep 設定。 | |

| 仮想マシンのイベントストリーム。 | |

| コンソールセッション管理。 | |

| スナップショット管理 | |

| ステータス条件とボリュームスナップショットのステータス |

3.3.3.1.1. Overview タブ

Overview タブには、リソースの使用率、アラート、および設定情報が表示されます。

例3.12 Overview タブ

| 要素 | 説明 |

|---|---|

| Details タイル | 一般的な仮想マシン情報。 |

| Utilization タイル | CPU、Memory、Storage、および Network transfer グラフ。デフォルトでは、ネットワーク転送 は、すべてのネットワークの合計を表示します。特定のネットワークの内訳を表示するには、Breakdown by network をクリックします。 |

| Hardware devices タイル | GPU とホストデバイス。 |

| Alerts タイル | 重大度別にグループ化された OpenShift Virtualization アラート。 |

| Snapshots タイル |

Take snapshot |

| Network interfaces タイル | Network interfaces テーブル。 |

| Disks タイル | Disks テーブル。 |

3.3.3.1.2. Details タブ

Details タブで、仮想マシンに関する情報を表示し、ラベル、アノテーション、およびその他のメタデータを編集します。

例3.13 Details タブ

| 要素 | 説明 |

|---|---|

| YAML スイッチ | ON を設定して、YAML 設定ファイルでライブの変更を表示します。 |

| Name | 仮想マシン名 |

| Namespace | 仮想マシンの namespace またはプロジェクト。 |

| Labels | 編集アイコンをクリックして、ラベルを編集します。 |

| Annotations | 編集アイコンをクリックして、注釈を編集します。 |

| Description | 編集アイコンをクリックして、説明を入力します。 |

| Operating system | オペレーティングシステム名。 |

| CPU|Memory | 編集アイコンをクリックして、CPU|Memory 要求を編集します。仮想マシンを再起動して、変更を適用します。

CPU の数は、 |

| Machine type | Machine テーブル。 |

| Boot mode | 編集アイコンをクリックして、起動モードを編集します。仮想マシンを再起動して、変更を適用します。 |

| 一時停止モードで開始 | 編集アイコンをクリックして、この設定を有効にします。仮想マシンを再起動して、変更を適用します。 |

| テンプレート | 仮想マシンの作成に使用されるテンプレートの名前。 |

| Created at | 仮想マシンの作成日。 |

| Owner | 仮想マシンの所有者。 |

| ステータス | 仮想マシンのステータス。 |

| Pod |

|

| VirtualMachineInstance | 仮想マシンのインスタンス名。 |

| Boot order | 編集アイコンをクリックして、起動ソースを選択します。仮想マシンを再起動して、変更を適用します。 |

| IP アドレス | 仮想マシンの IP アドレス。 |

| Hostname | 仮想マシンのホスト名。仮想マシンを再起動して、変更を適用します。 |

| タイムゾーン | 仮想マシンのタイムゾーン。 |

| ノード | 仮想マシンが実行しているノード。 |

| Workload profile | 編集アイコンをクリックして、ワークロードプロファイルを編集します。 |

| SSH アクセス | これらの設定は Linux に適用されます。 |

| virtctl を使用している SSH |

コピーアイコンをクリックして、 |

| SSH サービスの種類 | SSH over LoadBalancer を選択します。 サービスを作成すると、SSH コマンドが表示されます。コピーアイコンをクリックして、コマンドをクリップボードにコピーします。 |

| GPU devices | 編集アイコンをクリックして、GPU デバイスを追加します。仮想マシンを再起動して、変更を適用します。 |

| Host devices | 編集アイコンをクリックして、ホストデバイスを追加します。仮想マシンを再起動して、変更を適用します。 |

| Headless mode | 編集アイコンをクリックしてヘッドレスモードを ON に設定し、VNC コンソールを無効にします。仮想マシンを再起動して、変更を適用します。 |

| サービス | QEMU ゲストエージェントがインストールされている場合は、サービスの一覧を表示します。 |

| アクティブなユーザー | QEMU ゲストエージェントがインストールされている場合、アクティブなユーザーのリストが表示されます。 |

3.3.3.1.3. Metrics タブ

Metrics タブには、メモリー、CPU、ストレージ、ネットワーク、および移行の使用率グラフが表示されます。

例3.14 Metrics タブ

| 要素 | 説明 |

|---|---|

| Time range リスト | 結果をフィルタリングする期間を選択します。 |

|

Virtualization ダッシュボード | 現在のプロジェクトの Workloads タブにリンクします。 |

| Utilization | Memory および CPU グラフ。 |

| Storage | Storage total read/write および Storage IOPS total read/write グラフ。 |

| Network | Network in、Network out、Network bandwidth、および Network interface グラフ。Network interface リストから All networks または特定のネットワークを選択します。 |

| Migration | Migration および KV data transfer rate グラフ。 |

3.3.3.1.4. YAML タブ

YAML タブで YAML ファイルを編集して、仮想マシンを設定します。

例3.15 YAML タブ

| 要素 | 説明 |

|---|---|

| Save ボタン | 変更を YAML ファイルに保存します。 |

| Reload ボタン | 変更を破棄し、YAML ファイルをリロードします。 |

| Cancel ボタン | YAML タブを終了します。 |

| Download ボタン | YAML ファイルをローカルマシンにダウンロードします。 |

3.3.3.1.5. Configuration タブ

Configuration タブで、スケジュール、ネットワークインターフェイス、ディスク、およびその他のオプションを設定します。

例3.16 Configuration タブ上のタブ

| 要素 | 説明 |

|---|---|

| YAML スイッチ | ON を設定して、YAML 設定ファイルでライブの変更を表示します。 |

| ディスク。 | |

| ネットワークインターフェイス。 | |

| スケジュールとリソースの要件。 | |

| 設定マップ、シークレット、およびサービスアカウント | |

| Cloud-init 設定、Linux 仮想マシンの承認済み SSH キー、Windows 仮想マシンの Sysprep アンサーファイル。 |

3.3.3.1.5.1. Disks タブ

ディスクは、Disks タブで管理します。

例3.17 Disks タブ

| 設定 | 説明 |

|---|---|

| Add disk ボタン | 仮想マシンにディスクを追加します。 |

| Filter フィールド | ディスクの種類でフィルタリングします。 |

| Search フィールド | ディスクを名前で検索します。 |

| Mount Windows drivers disk チェックボックス |

VirtIO ドライバーをインストールするために、 |

| Disks テーブル | 仮想マシンのディスクのリスト。

ディスクの横にある actions メニュー

|

| File systems テーブル | 仮想マシンのファイルシステムのリスト。 |

3.3.3.1.5.2. Network interfaces タブ

Network interfaces タブでネットワークインターフェイスを管理します。

例3.18 Network interfaces タブ

| 設定 | 説明 |

|---|---|

| Add network interface ボタン | 仮想マシンにネットワークインターフェイスを追加します。 |

| Filter フィールド | インターフェイスタイプでフィルタリングします。 |

| Search フィールド | 名前またはラベルでネットワークインターフェイスを検索します。 |

| Network interface テーブル | ネットワークインターフェイスのリスト。

ネットワークインターフェイスの横にある actions メニュー

|

3.3.3.1.5.3. Scheduling タブ

Scheduling タブで、特定のノードで実行されるように仮想マシンを設定します。

仮想マシンを再起動して変更を適用します。

例3.19 Scheduling タブ

| 設定 | 説明 |

|---|---|

| Node selector | 編集アイコンをクリックして、ラベルを追加し、適格なノードを指定します。 |

| 容認 | 編集アイコンをクリックして、許容範囲を追加し、適格なノードを指定します。 |

| アフィニティールール | 編集アイコンをクリックして、アフィニティールールを追加します。 |

| Descheduler スイッチ | Descheduler を有効または無効にします。Descheduler は、実行中の Pod をエビクトして、Pod をより適切なノードに再スケジュールできるようにします。 仮想マシンをライブマイグレーションできない場合、このフィールドは無効になります。 |

| 専用リソース | 編集アイコンをクリックして、Schedule this workload with dedicated resources (guaranteed policy) を選択します。 |

| エビクションストラテジー | 編集アイコンをクリックして、仮想マシンのエビクション戦略として LiveMigrate を選択します。 |

3.3.3.1.5.4. Environment タブ

Environment タブで設定マップ、シークレット、およびサービスアカウントを管理します。

例3.20 Environment タブ

| 要素 | 説明 |

|---|---|

|

Add Config Map, Secret or Service Account | リンクをクリックして、リソースリストから設定マップ、シークレット、またはサービスアカウントを選択します。 |

3.3.3.1.5.5. Scripts タブ

Scripts タブで、cloud-init 設定の管理、SSH キーの追加、または Windows 仮想マシン用の Sysprep の設定を行います。

仮想マシンを再起動して変更を適用します。

例3.21 Scripts タブ

| 要素 | 説明 |

|---|---|

| Cloud-init | 編集アイコンをクリックして、cloud-init 設定を編集します。 |

| 認可された SSH キー | 編集アイコンをクリックして、公開 SSH キーを Linux 仮想マシンに追加します。 キーは初回起動時に cloud-init データソースとして追加されます。 |

| Dynamic SSH key injection スイッチ | 動的公開 SSH キーインジェクションを有効にするには、Dynamic SSH key injection をオンに設定します。その後、実行時にキーを追加または取り消すことができます。 動的 SSH キーインジェクションは、Red Hat Enterprise Linux (RHEL) 9 でのみサポートされています。この設定を手動で無効にすると、仮想マシンは作成元のイメージの SSH キー設定を継承します。 |

| Sysprep |

編集アイコンをクリックして |

3.3.3.1.6. Events タブ

Events タブには、仮想マシンイベントのリストが表示されます。

3.3.3.1.7. Console タブ

Console タブで仮想マシンへのコンソールセッションを開くことができます。

例3.22 Console タブ

| 要素 | 説明 |

|---|---|

| Guest login credentials セクション |

Guest login credentials を展開して、 |

| Console リスト | VNC コンソール または Serial コンソール を選択します。 Windows 仮想マシンの場合は、Desktop viewer オプションが表示されます。同じネットワーク上のマシンに RDP クライアントをインストールする必要があります。 |

| Send key リスト | コンソールに送信するキーストロークの組み合わせを選択します。 |

| Disconnect ボタン | コンソール接続を切断します。 新しいコンソールセッションを開く場合は、コンソール接続を手動で切断する必要があります。それ以外の場合、最初のコンソールセッションは引き続きバックグラウンドで実行されます。 |

| Paste ボタン | 文字列をクリップボードから VNC コンソールに貼り付けます。 |

3.3.3.1.8. Snapshots タブ

Snapshots タブでスナップショットを作成し、スナップショットから仮想マシンを復元します。

例3.23 Snapshots タブ

| 要素 | 説明 |

|---|---|

| Take snapshot ボタン | スナップショットを作成します。 |

| Filter フィールド | スナップショットをステータスでフィルタリングします。 |

| Search フィールド | 名前またはラベルでスナップショットを検索します。 |

| Snapshot テーブル | スナップショットのリスト。 スナップショット名をクリックして、ラベルまたはアノテーションを編集します。

スナップショットの横にある actions メニュー

|

3.3.3.1.9. Diagnostics タブ

Diagnostics タブでステータス条件とボリュームスナップショットのステータスを表示します。

例3.24 Diagnostics タブ

| 要素 | 説明 |

|---|---|

| Status conditions テーブル | 仮想マシンに関して報告された状態のリストを表示します。 |

| Filter フィールド | ステータス条件をカテゴリーと条件でフィルタリングします。 |

| Search フィールド | ステータス条件を理由で検索します。 |

| Manage columns アイコン | テーブルに表示する列を最大 9 つ選択します。 |

| Volume snapshot status テーブル | ボリューム、スナップショットの有効化ステータス、および理由のリスト |

3.3.4. Templates ページ

VirtualMachine Templates ページで仮想マシンテンプレートを作成、編集、およびクローン作成します。

Red Hat テンプレートは編集できません。ただし、Red Hat テンプレートを複製して編集し、カスタムテンプレートを作成できます。

例3.25 VirtualMachine Templates ページ

| 要素 | 説明 |

|---|---|

| Create Template ボタン | YAML 設定ファイルを編集してテンプレートを作成します。 |

| Filter フィールド | テンプレートをタイプ、ブートソース、テンプレートプロバイダー、またはオペレーティングシステムでフィルタリングします。 |

| Search フィールド | 名前またはラベルでテンプレートを検索します。 |

| Manage columns アイコン | テーブルに表示する列を最大 9 つ選択します。Namespace 列は、Projects リストから All Projects が選択されている場合にのみ表示されます。 |

| 仮想マシンテンプレートテーブル | 仮想マシンテンプレートのリスト。

テンプレートの横にある actions メニュー

|

3.3.4.1. テンプレートの詳細ページ

Template details ページで、テンプレートの設定を表示し、カスタムテンプレートを編集します。

例3.26 Template details タブ

| 要素 | 説明 |

|---|---|

| YAML スイッチ | ON を設定して、YAML 設定ファイルでライブの変更を表示します。 |

| Actions メニュー | Actions メニューをクリックして、Edit、Clone、Edit boot source、Edit boot source reference の Edit labels の Edit annotations、または Delete を選択します。 |

| テンプレートの設定と設定。 | |

| YAML 設定ファイル。 | |

| スケジューリング設定。 | |

| ネットワークインターフェイス管理。 | |

| ディスク管理。 | |

| Cloud-init、SSH キー、および Sysprep の管理。 | |

| 名前とクラウドユーザーのパスワード管理。 |

3.3.4.1.1. Details タブ

Details タブでカスタムテンプレートを設定します。

例3.27 Details タブ

| 要素 | 説明 |

|---|---|

| Name | テンプレート名 |

| Namespace | テンプレートの namespace。 |

| Labels | 編集アイコンをクリックして、ラベルを編集します。 |

| Annotations | 編集アイコンをクリックして、注釈を編集します。 |

| Display name | 編集アイコンをクリックして、表示名を編集します。 |

| Description | 編集アイコンをクリックして、説明を入力します。 |

| Operating system | オペレーティングシステム名。 |

| CPU|Memory | 編集アイコンをクリックして、CPU|Memory 要求を編集します。

CPU の数は、 |

| Machine type | テンプレートマシンタイプ。 |

| Boot mode | 編集アイコンをクリックして、起動モードを編集します。 |

| Base template | このテンプレートの作成に使用されたベーステンプレートの名前。 |

| Created at | テンプレートの作成日。 |

| Owner | テンプレート所有者。 |

| Boot order | テンプレートの起動順序。 |

| Boot source | ブートソースの可用性。 |

| Provider | テンプレートプロバイダー |

| Support | テンプレートのサポートレベル。 |

| GPU devices | 編集アイコンをクリックして、GPU デバイスを追加します。 |

| Host devices | 編集アイコンをクリックして、ホストデバイスを追加します。 |

| Headless mode | 編集アイコンをクリックしてヘッドレスモードを ON に設定し、VNC コンソールを無効にします。 |

3.3.4.1.2. YAML タブ

YAML タブで YAML ファイルを編集して、カスタムテンプレートを設定します。

例3.28 YAML タブ

| 要素 | 説明 |

|---|---|

| Save ボタン | 変更を YAML ファイルに保存します。 |

| Reload ボタン | 変更を破棄し、YAML ファイルをリロードします。 |

| Cancel ボタン | YAML タブを終了します。 |

| Download ボタン | YAML ファイルをローカルマシンにダウンロードします。 |

3.3.4.1.3. Scheduling タブ

Scheduling タブでスケジュールを設定します。

例3.29 Scheduling タブ

| 設定 | 説明 |

|---|---|

| Node selector | 編集アイコンをクリックして、ラベルを追加し、適格なノードを指定します。 |

| 容認 | 編集アイコンをクリックして、許容範囲を追加し、適格なノードを指定します。 |

| アフィニティールール | 編集アイコンをクリックして、アフィニティールールを追加します。 |

| Descheduler スイッチ | Descheduler を有効または無効にします。Descheduler は、実行中の Pod をエビクトして、Pod をより適切なノードに再スケジュールできるようにします。 |

| 専用リソース | 編集アイコンをクリックして、Schedule this workload with dedicated resources (guaranteed policy) を選択します。 |

| エビクションストラテジー | 編集アイコンをクリックして、仮想マシンのエビクション戦略として LiveMigrate を選択します。 |

3.3.4.1.4. Network interfaces タブ

Network interfaces タブでネットワークインターフェイスを管理します。

例3.30 Network interfaces タブ

| 設定 | 説明 |

|---|---|

| Add network interface ボタン | テンプレートにネットワークインターフェイスを追加します。 |

| Filter フィールド | インターフェイスタイプでフィルタリングします。 |

| Search フィールド | 名前またはラベルでネットワークインターフェイスを検索します。 |

| Network interface テーブル | ネットワークインターフェイスのリスト。

ネットワークインターフェイスの横にある actions メニュー

|

3.3.4.1.5. Disks タブ

ディスクは、Disks タブで管理します。

例3.31 Disks タブ

| 設定 | 説明 |

|---|---|

| Add disk ボタン | テンプレートにディスクを追加します。 |

| Filter フィールド | ディスクの種類でフィルタリングします。 |

| Search フィールド | ディスクを名前で検索します。 |

| Disks テーブル | テンプレートディスクのリスト。

ディスクの横にある actions メニュー

|

3.3.4.1.6. Scripts タブ

Scripts タブで、cloud-init 設定、SSH キー、および Sysprep 応答ファイルを管理します。

例3.32 Scripts タブ

| 要素 | 説明 |

|---|---|

| Cloud-init | 編集アイコンをクリックして、cloud-init 設定を編集します。 |

| 認可された SSH キー | 編集アイコンをクリックして、新しいシークレットを作成するか、既存のシークレットを Linux 仮想マシンに割り当てます。 |

| Sysprep |

編集アイコンをクリックして |

3.3.4.1.7. パラメータータブ

パラメーター タブで、選択したテンプレート設定を編集します。

例3.33 Parameters タブ

| 要素 | 説明 |

|---|---|

| 名前 | このテンプレートから作成された仮想マシンの名前パラメーターを設定します。 |

| CLOUD_USER_PASSWORD | このテンプレートから作成された仮想マシンのクラウドユーザーパスワードパラメーターを設定します。 |

3.3.5. InstanceTypes ページ

InstanceTypes ページで仮想マシンインスタンスタイプを表示および管理します。

例3.34 VirtualMachineClusterInstancetypes ページ

| 要素 | 説明 |

|---|---|

| Create ボタン | YAML 設定ファイルを編集して、インスタンスタイプを作成します。 |

| Search フィールド | インスタンスタイプを名前またはラベルで検索します。 |

| Manage columns アイコン | テーブルに表示する列を最大 9 つ選択します。Namespace 列は、Projects リストから All Projects が選択されている場合にのみ表示されます。 |

| Instance types テーブル | インスタンスのリスト。

インスタンスタイプの横にあるアクションメニュー

|

インスタンスタイプをクリックして、VirtualMachineClusterInstancetypes details ページを表示します。

3.3.5.1. VirtualMachineClusterInstancetypes details ページ

VirtualMachineClusterInstancetypes details ページでインスタンスタイプを設定します。

例3.35 VirtualMachineClusterInstancetypes details ページ

| 要素 | 説明 |

|---|---|

| Details タブ | フォームを編集してインスタンスタイプを設定します。 |

| YAML タブ | YAML 設定ファイルを編集して、インスタンスタイプを設定します。 |

| Actions メニュー | Edit labels、Edit annotations、Edit VirtualMachineClusterInstancetype、または Delete VirtualMachineClusterInstancetype を選択します。 |

3.3.5.1.1. Details タブ

インスタンスタイプを設定するには、Details タブでフォームを編集します。

例3.36 Details タブ

| 要素 | 説明 |

|---|---|

| Name | VirtualMachineClusterInstancetype の名前。 |

| Labels | 編集アイコンをクリックして、ラベルを編集します。 |

| Annotations | 編集アイコンをクリックして、注釈を編集します。 |

| Created at | インスタンスタイプの作成日。 |

| Owner | インスタンスタイプの所有者。 |

3.3.5.1.2. YAML タブ

インスタンスタイプを設定するには、YAML タブで YAML ファイルを編集します。

例3.37 YAML タブ

| 要素 | 説明 |

|---|---|

| Save ボタン | 変更を YAML ファイルに保存します。 |

| Reload ボタン | 変更を破棄し、YAML ファイルをリロードします。 |

| Cancel ボタン | YAML タブを終了します。 |

| Download ボタン | YAML ファイルをローカルマシンにダウンロードします。 |

3.3.6. Preferences ページ

Preferences ページで仮想マシンの設定を表示および管理します。

例3.38 VirtualMachineClusterPreferences ページ

| 要素 | 説明 |

|---|---|

| Create ボタン | YAML 設定ファイルを編集して設定を作成します。 |

| Search フィールド | 名前またはラベルで設定を検索します。 |

| Manage columns アイコン | テーブルに表示する列を最大 9 つ選択します。Namespace 列は、Projects リストから All Projects が選択されている場合にのみ表示されます。 |

| Preferences テーブル | 設定のリスト。

設定の横にあるアクションメニュー

|

設定をクリックして、VirtualMachineClusterPreference details ページを表示します。

3.3.6.1. VirtualMachineClusterPreference details ページ

VirtualMachineClusterPreference details ページで設定を指定します。

例3.39 VirtualMachineClusterPreference details ページ

| 要素 | 説明 |

|---|---|

| Details タブ | フォームを編集して設定を指定します。 |

| YAML タブ | YAML 設定ファイルを編集して設定を指定します。 |

| Actions メニュー | Edit labels、Edit annotations、Edit VirtualMachineClusterPreference、または Delete VirtualMachineClusterPreference を選択します。 |

3.3.6.1.1. Details タブ

Details タブでフォームを編集して設定を指定します。

例3.40 Details タブ

| 要素 | 説明 |

|---|---|

| Name | VirtualMachineClusterPreference の名前。 |

| Labels | 編集アイコンをクリックして、ラベルを編集します。 |

| Annotations | 編集アイコンをクリックして、注釈を編集します。 |

| Created at | 設定の作成日。 |

| Owner | 設定の所有者。 |

3.3.6.1.2. YAML タブ

設定タイプを設定するには、YAML タブで YAML ファイルを編集します。

例3.41 YAML タブ

| 要素 | 説明 |

|---|---|

| Save ボタン | 変更を YAML ファイルに保存します。 |

| Reload ボタン | 変更を破棄し、YAML ファイルをリロードします。 |

| Cancel ボタン | YAML タブを終了します。 |

| Download ボタン | YAML ファイルをローカルマシンにダウンロードします。 |

3.3.7. Bootable volumes ページ

Bootable volumes ページで、使用可能なブート可能ボリュームを表示および管理します。

例3.42 Bootable volumes ページ

| 要素 | 説明 |

|---|---|

| Add volume ボタン | フォームに入力するか、YAML 設定ファイルを編集して、ブート可能ボリュームを追加します。 |

| Filter フィールド | ブート可能ボリュームをオペレーティングシステムとリソースタイプでフィルタリングします。 |

| Search フィールド | ブート可能ボリュームを名前またはラベルで検索します。 |

| Manage columns アイコン | テーブルに表示する列を最大 9 つ選択します。Namespace 列は、Projects リストから All Projects が選択されている場合にのみ表示されます。 |

| ブート可能ボリュームテーブル | ブート可能なボリュームのリスト。

ブート可能ボリュームの横にあるアクションメニュー

|

ブート可能ボリュームをクリックして、PersistentVolumeClaim details ページを表示します。

3.3.7.1. PersistentVolumeClaim details ページ

PersistentVolumeClaim details ページでブート可能ボリュームの永続ボリューム要求 (PVC) を設定します。

例3.43 PersistentVolumeClaim details ページ

| 要素 | 説明 |

|---|---|

| Details タブ | フォームを編集して PVC を設定します。 |

| YAML タブ | YAML 設定ファイルを編集して PVC を設定します。 |

| Events タブ | Events タブには、PVC イベントのリストが表示されます。 |

| VolumeSnapshots タブ | VolumeSnapshots タブには、ボリュームスナップショットのリストが表示されます。 |

| Actions メニュー | Expand PVC、Create snapshot、Clone PVC、Edit labels、Edit annotations、Edit PersistentVolumeClaim、または Delete PersistentVolumeClaim を選択します。 |

3.3.7.1.1. Details タブ

Details タブのフォームを編集して、ブート可能ボリュームの永続ボリューム要求 (PVC) を設定します。

例3.44 Details タブ

| 要素 | 説明 |

|---|---|

| Name | PVC の名前。 |

| Namespace | PVC の namespace。 |

| Labels | 編集アイコンをクリックして、ラベルを編集します。 |

| Annotations | 編集アイコンをクリックして、注釈を編集します。 |

| Created at | PVC の作成日。 |

| Owner | PVC の所有者。 |

| ステータス | PVC のステータス (Bound など)。 |

| Requested capacity | PVC の要求された容量。 |

| 容量 | PVC の容量。 |

| Used | PVC の使用済み領域。 |

| アクセスモード | PVC のアクセスモード。 |

| ボリュームモード | PVC のボリュームモード。 |

| StorageClasses | PVC のストレージクラス。 |

| PersistentVolumes | PVC に関連付けられた永続ボリューム。 |

| 条件 表 | PVC のステータスを表示します。 |

3.3.7.1.2. YAML タブ

ブート可能ボリュームの永続ボリューム要求を設定するには、YAML タブで YAML ファイルを編集します。

例3.45 YAML タブ

| 要素 | 説明 |

|---|---|

| Save ボタン | 変更を YAML ファイルに保存します。 |

| Reload ボタン | 変更を破棄し、YAML ファイルをリロードします。 |

| Cancel ボタン | YAML タブを終了します。 |

| Download ボタン | YAML ファイルをローカルマシンにダウンロードします。 |

3.3.8. MigrationPolicies ページ

MigrationPolicies ページでワークロードの移行ポリシーを管理します。

例3.46 MigrationPolicies ページ

| 要素 | 説明 |

|---|---|

| 移行ポリシーの作成 | フォームに設定とラベルを入力するか、YAML ファイルを編集して、移行ポリシーを作成します。 |

| Search フィールド | 名前またはラベルで移行ポリシーを検索します。 |

| Manage columns アイコン | テーブルに表示する列を最大 9 つ選択します。Namespace 列は、Projects リストから All Projects が選択されている場合にのみ表示されます。 |

| MigrationPolicies テーブル | 移行ポリシーのリスト。

移行ポリシーの横にあるアクションメニュー

|

移行ポリシーをクリックして、MigrationPolicy details ページを表示します。

3.3.8.1. MigrationPolicy details ページ

移行ポリシーは、MigrationPolicy details ページで設定します。

例3.47 MigrationPolicy details ページ

| 要素 | 説明 |

|---|---|

| Details タブ | フォームを編集して移行ポリシーを設定します。 |

| YAML タブ | YAML 設定ファイルを編集して、移行ポリシーを設定します。 |

| Actions メニュー | Edit または Delete を選択します。 |

3.3.8.1.1. Details タブ

Details タブでカスタムテンプレートを設定します。

例3.48 Details タブ

| 要素 | 説明 |

|---|---|

| Name | 移行ポリシー名。 |

| Description | 移行ポリシーの説明。 |

| 設定 | 編集アイコンをクリックして、移行ポリシー設定を更新します。 |

| 移行ごとの帯域幅 |

移行ごとの帯域幅要求。帯域幅を無制限にするには、値を |

| 自動収束 | 自動収束が有効になっている場合は、移行を確実に成功させるために、仮想マシンのパフォーマンスと可用性が低下する可能性があります。 |

| ポストコピー | ポストコピーポリシー。 |

| 完了タイムアウト | 秒単位の完了タイムアウト値。 |

| プロジェクトラベル | Edit をクリックして、プロジェクトラベルを編集します。 |

| VirtualMachine のラベル | Edit をクリックして仮想マシンのラベルを編集します。 |

3.3.8.1.2. YAML タブ

移行ポリシーを設定するには、YAML タブで YAML ファイルを編集します。

例3.49 YAML タブ

| 要素 | 説明 |

|---|---|

| Save ボタン | 変更を YAML ファイルに保存します。 |

| Reload ボタン | 変更を破棄し、YAML ファイルをリロードします。 |

| Cancel ボタン | YAML タブを終了します。 |

| Download ボタン | YAML ファイルをローカルマシンにダウンロードします。 |

第4章 インストール

4.1. OpenShift Virtualization のクラスターの準備

OpenShift Virtualization をインストールする前にこのセクションを確認して、クラスターが要件を満たしていることを確認してください。

- インストール方法の考慮事項

- ユーザープロビジョニング、インストーラープロビジョニング、またはアシステッドインストーラーなど、任意のインストール方法を使用して、OpenShift Container Platform をデプロイできます。ただし、インストール方法とクラスタートポロジーは、スナップショットや ライブマイグレーション などの OpenShift Virtualization 機能に影響を与える可能性があります。

- Red Hat OpenShift Data Foundation

- Red Hat OpenShift Data Foundation を使用して OpenShift Virtualization をデプロイする場合は、Windows 仮想マシンディスク用の専用ストレージクラスを作成する必要があります。詳細は 、Windows VM の ODF PersistentVolumes の最適化 を参照してください。

- IPv6

- シングルスタックの IPv6 クラスターで OpenShift Virtualization は実行できません。

FIPS モード

クラスターを FIPS モード でインストールする場合、OpenShift Virtualization に追加の設定は必要ありません。

4.1.1. サポート対象のプラットフォーム

OpenShift Virtualization では、以下のプラットフォームを使用できます。

- オンプレミスのベアメタルサーバー。OpenShift 仮想化のためのベアメタルクラスターの計画 を参照してください。

IBM Cloud® ベアメタルサーバー。Deploy OpenShift Virtualization on IBM Cloud® Bare Metal nodes を参照してください。

重要IBM Cloud® ベアメタルサーバーへの OpenShift Virtualization のインストールは、テクノロジープレビュー機能としてのみ提供されます。テクノロジープレビュー機能は、Red Hat 製品サポートのサービスレベルアグリーメント (SLA) の対象外であり、機能的に完全ではない場合があります。Red Hat は、実稼働環境でこれらを使用することを推奨していません。テクノロジープレビューの機能は、最新の製品機能をいち早く提供して、開発段階で機能のテストを行いフィードバックを提供していただくことを目的としています。

Red Hat のテクノロジープレビュー機能のサポート範囲に関する詳細は、テクノロジープレビュー機能のサポート範囲 を参照してください。

他のクラウドプロバイダーが提供するベアメタルインスタンスまたはサーバーはサポートされていません。

4.1.1.1. AWS ベアメタル上の OpenShift Virtualization

OpenShift Virtualization は、Amazon Web Services (AWS) ベアメタル OpenShift Container Platform クラスターで実行できます。

OpenShift Virtualization は、AWS ベアメタルクラスターと同じ設定要件を持つ Red Hat OpenShift Service on AWS (ROSA) Classic クラスターでもサポートされています。

クラスターを設定する前に、サポート対象の機能と制限に関する以下の要約を確認してください。

- インストール

installer-provisioned infrastructure を使用してクラスターをインストールできます。その際に、

install-config.yamlファイルを編集してワーカーノードのベアメタルインスタンスタイプを確実に指定してください。たとえば、x86_64 アーキテクチャーをベースとするマシンのc5n.metalタイプの値を使用できます。詳細は、AWS へのインストールに関する OpenShift Container Platform ドキュメントを参照してください。

- 仮想マシン (VM) へのアクセス

-

virtctlCLI ツールまたは OpenShift Container Platform Web コンソールを使用して仮想マシンにアクセスする方法に変更はありません。 NodePortまたはLoadBalancerサービスを使用して、仮想マシンを公開できます。- OpenShift Container Platform は AWS でロードバランサーを自動的に作成し、そのライフサイクルを管理するため、ロードバランサーのアプローチが推奨されます。また、セキュリティーグループはロードバランサー用にも作成され、アノテーションを使用して既存のセキュリティーグループをアタッチできます。サービスを削除すると、OpenShift Container Platform はロードバランサーとそれに関連付けられたリソースを削除します。

- ネットワーク

- Single Root I/O Virtualization (SR-IOV) またはブリッジ Container Network Interface (CNI) ネットワーク (仮想 LAN (VLAN) を含む) は使用できません。アプリケーションにフラットレイヤー 2 ネットワークが必要な場合や、IP プールを制御する必要がある場合は、OVN-Kubernetes セカンダリーオーバーレイネットワークを使用することを検討してください。

- ストレージ

基盤となるプラットフォームとの連携がストレージベンダーによって認定されている任意のストレージソリューションを使用できます。

重要AWS ベアメタルクラスターと ROSA クラスターでは、サポートされているストレージソリューションが異なる場合があります。ストレージベンダーにサポートを確認してください。

- Amazon Elastic File System (EFS) および Amazon Elastic Block Store (EBS) は、パフォーマンスと機能が限定されるため、OpenShift Virtualization での使用は推奨されません。代わりに共有ストレージを使用してください。

4.1.2. ハードウェアとオペレーティングシステムの要件

OpenShift Virtualization の次のハードウェアおよびオペレーティングシステム要件を確認してください。

4.1.2.1. CPU の要件

Red Hat Enterprise Linux (RHEL) 9 でサポート。

サポートされている CPU の Red Hat Ecosystem Catalog を参照してください。

注記ワーカーノードの CPU が異なる場合は、CPU ごとに機能が異なるため、ライブマイグレーションが失敗する可能性があります。この問題は、ワーカーノードに適切な容量の CPU が搭載されていることを確認し、仮想マシンのノードアフィニティールールを設定することで軽減できます。

詳細は、必要なノードアフィニティールールの設定 を参照してください。

- AMD および Intel 64 ビットアーキテクチャー (x86-64-v2) のサポート。

- Intel 64 または AMD64 CPU 拡張機能のサポート。

- Intel VT または AMD-V ハードウェア仮想化拡張機能が有効化されている。

- NX (実行なし) フラグが有効。

4.1.2.2. オペレーティングシステム要件

ワーカーノードにインストールされた Red Hat Enterprise Linux CoreOS (RHCOS)。

詳細は、RHCOS について を参照してください。

注記RHEL ワーカー ノードはサポートされていません。

4.1.2.3. ストレージ要件

- OpenShift Container Platform によるサポート。Optimizing storage を参照してください。

- デフォルトの OpenShift Virtualization または OpenShift Container Platform ストレージクラスを作成する必要があります。これは、仮想マシンワークロード固有のストレージニーズに対応し、最適化されたパフォーマンス、信頼性、ユーザーエクスペリエンスを提供することを目的としています。OpenShift Virtualization と OpenShift Container Platform の両方にデフォルトのストレージクラスが存在する場合、仮想マシンディスクの作成時には OpenShift Virtualization のクラスが優先されます。

クラスターのデフォルトのストレージクラスを指定する必要があります。デフォルトストレージクラスの管理 を参照してください。デフォルトのストレージクラスプロビジョナーが ReadWriteMany (RWX) アクセスモード をサポートしている場合は、最適なパフォーマンスを得るために、関連する永続ボリュームに RWX モードを使用してください。

ストレージプロビジョナーがスナップショットをサポートしている場合は、デフォルトのストレージクラスに関連付けられた VolumeSnapshotClass オブジェクトが必要です。

4.1.2.3.1. 仮想マシンディスクのボリュームとアクセスモードについて

既知のストレージプロバイダーでストレージ API を使用する場合、ボリュームモードとアクセスモードは自動的に選択されます。ただし、ストレージプロファイルのないストレージクラスを使用する場合は、ボリュームとアクセスモードを設定する必要があります。

最良の結果を得るには、ReadWriteMany (RWX) アクセスモードと Block ボリュームモードを使用してください。これは、以下の理由により重要です。

-

ライブマイグレーションには

ReadWriteMany(RWX) アクセスモードが必要です。 Blockボリュームモードは、Filesystemボリュームモードよりもパフォーマンスが大幅に優れています。これは、Filesystemボリュームモードでは、ファイルシステムレイヤーやディスクイメージファイルなどを含め、より多くのストレージレイヤーが使用されるためです。仮想マシンのディスクストレージに、これらのレイヤーは必要ありません。たとえば、Red Hat OpenShift Data Foundation を使用する場合は、CephFS ボリュームよりも Ceph RBD ボリュームの方が推奨されます。

次の設定の仮想マシンをライブマイグレーションすることはできません。

-

ReadWriteOnce(RWO) アクセスモードのストレージボリューム - GPU などのパススルー機能

それらの仮想マシンの evictionStrategy フィールドを LiveMigrate に設定しないでください。

4.1.3. ライブマイグレーションの要件

-

ReadWriteMany(RWX) アクセスモードの共有ストレージ 十分な RAM およびネットワーク帯域幅

注記ライブマイグレーションを引き起こすノードドレインをサポートするために、クラスター内に十分なメモリーリクエスト容量があることを確認する必要があります。以下の計算を使用して、必要な予備のメモリーを把握できます。

Product of (Maximum number of nodes that can drain in parallel) and (Highest total VM memory request allocations across nodes)

クラスターで 並行して実行できるデフォルトの移行数 は 5 です。

- 仮想マシンがホストモデルの CPU を使用する場合、ノードは仮想マシンのホストモデルの CPU をサポートする必要があります。

- ライブマイグレーション 専用の Multus ネットワーク を強く推奨します。専用ネットワークは、移行中のテナントワークロードに対するネットワークの飽和状態の影響を最小限に抑えます。

4.1.4. 物理リソースのオーバーヘッド要件

OpenShift Virtualization は OpenShift Container Platform のアドオンであり、クラスターの計画時に考慮する必要のある追加のオーバーヘッドを強要します。各クラスターマシンは、OpenShift Container Platform の要件に加えて、以下のオーバーヘッドの要件を満たす必要があります。クラスター内の物理リソースを過剰にサブスクライブすると、パフォーマンスに影響する可能性があります。

本書に記載されている数は、Red Hat のテスト方法およびセットアップに基づいています。これらの数は、独自のセットアップおよび環境に応じて異なります。

メモリーのオーバーヘッド

以下の式を使用して、OpenShift Virtualization のメモリーオーバーヘッドの値を計算します。

クラスターメモリーのオーバーヘッド

Memory overhead per infrastructure node ≈ 150 MiB

Memory overhead per worker node ≈ 360 MiB

さらに、OpenShift Virtualization 環境リソースには、すべてのインフラストラクチャーノードに分散される合計 2179 MiB の RAM が必要です。

仮想マシンのメモリーオーバーヘッド

Memory overhead per virtual machine ≈ (1.002 × requested memory) \

+ 218 MiB \ 1

+ 8 MiB × (number of vCPUs) \ 2

+ 16 MiB × (number of graphics devices) \ 3

+ (additional memory overhead) 4

- 1

virt-launcherPod で実行されるプロセスに必要です。- 2

- 仮想マシンが要求する仮想 CPU の数。

- 3

- 仮想マシンが要求する仮想グラフィックスカードの数。

- 4

- 追加のメモリーオーバーヘッド:

- お使いの環境に Single Root I/O Virtualization (SR-IOV) ネットワークデバイスまたは Graphics Processing Unit (GPU) が含まれる場合、それぞれのデバイスに 1 GiB の追加のメモリーオーバーヘッドを割り当てます。

- Secure Encrypted Virtualization (SEV) が有効な場合は、256 MiB を追加します。

- Trusted Platform Module (TPM) が有効な場合は、53 MiB を追加します。

CPU オーバーヘッド

以下の式を使用して、OpenShift Virtualization のクラスタープロセッサーのオーバーヘッド要件を計算します。仮想マシンごとの CPU オーバーヘッドは、個々の設定によって異なります。

クラスターの CPU オーバーヘッド

CPU overhead for infrastructure nodes ≈ 4 cores

OpenShift Virtualization は、ロギング、ルーティング、およびモニタリングなどのクラスターレベルのサービスの全体的な使用率を増加させます。このワークロードに対応するには、インフラストラクチャーコンポーネントをホストするノードに、4 つの追加コア (4000 ミリコア) の容量があり、これがそれらのノード間に分散されていることを確認します。

CPU overhead for worker nodes ≈ 2 cores + CPU overhead per virtual machine

仮想マシンをホストする各ワーカーノードには、仮想マシンのワークロードに必要な CPU に加えて、OpenShift Virtualization 管理ワークロード用に 2 つの追加コア (2000 ミリコア) の容量が必要です。

仮想マシンの CPU オーバーヘッド

専用の CPU が要求される場合は、仮想マシン 1 台につき CPU 1 つとなり、クラスターの CPU オーバーヘッド要件に影響が出てきます。それ以外の場合は、仮想マシンに必要な CPU の数に関する特別なルールはありません。

ストレージのオーバーヘッド

以下のガイドラインを使用して、OpenShift Virtualization 環境のストレージオーバーヘッド要件を見積もります。

クラスターストレージオーバーヘッド

Aggregated storage overhead per node ≈ 10 GiB

10 GiB は、OpenShift Virtualization のインストール時にクラスター内の各ノードについてのディスク上のストレージの予想される影響に相当します。

仮想マシンのストレージオーバーヘッド

仮想マシンごとのストレージオーバーヘッドは、仮想マシン内のリソース割り当ての特定の要求により異なります。この要求は、クラスター内の別の場所でホストされるノードまたはストレージリソースの一時ストレージに対するものである可能性があります。OpenShift Virtualization は現在、実行中のコンテナー自体に追加の一時ストレージを割り当てていません。

例

クラスター管理者が、クラスター内の 10 台の (それぞれ 1 GiB の RAM と 2 つの vCPU の) 仮想マシンをホストする予定の場合、クラスター全体で影響を受けるメモリーは 11.68 GiB になります。クラスターの各ノードについて予想されるディスク上のストレージの影響は 10 GiB で示され、仮想マシンのワークロードをホストするワーカーノードについての CPU の影響は最小 2 コアで示されます。

4.1.5. 単一ノードの Openshift の違い

OpenShift Virtualization は単一ノード OpenShift にインストールできます。

ただし、単一ノード OpenShift は次の機能をサポートしていないことに注意してください。

- 高可用性

- Pod の中断

- ライブマイグレーション

- エビクション戦略が設定されている仮想マシンまたはテンプレート

4.1.6. オブジェクトの最大値

クラスターを計画するときは、次のテスト済みオブジェクトの最大数を考慮する必要があります。

4.1.7. クラスターの高可用性オプション

クラスターには、次の高可用性 (HA) オプションのいずれかを設定できます。

インストーラーによってプロビジョニングされたインフラストラクチャー (IPI) の 自動高可用性は、マシンヘルスチェック をデプロイすることで利用できます。

注記インストーラーによってプロビジョニングされたインフラストラクチャーを使用し、適切に設定された

MachineHealthCheckリソースを使用してインストールされた OpenShift Container Platform クラスターでは、ノードがマシンヘルスチェックに失敗し、クラスターで使用できなくなった場合、そのノードはリサイクルされます。障害が発生したノードで実行された仮想マシンでは、一連の条件によって次に起こる動作が変わります。潜在的な結果と、実行戦略がそれらの結果にどのように影響するかに関する詳細は、戦略の実行 を参照してください。-

IPI と非 IPI の両方の自動高可用性は、OpenShift Container Platform クラスターで Node Health Check Operator を使用して

NodeHealthCheckコントローラーをデプロイすることで利用できます。コントローラーは異常なノードを特定し、Self Node Remediation Operator や Fence Agents Remediation Operator などの修復プロバイダーを使用して異常なノードを修復します。ノードの修復、フェンシング、メンテナンスについて、詳しくは Red Hat OpenShift のワークロードの可用性 を参照してください。 モニタリングシステムまたは有資格者を使用してノードの可用性をモニターすることにより、あらゆるプラットフォームの高可用性を利用できます。ノードが失われた場合は、これをシャットダウンして

oc delete node <lost_node>を実行します。注記外部モニタリングシステムまたは資格のある人材によるノードの正常性の監視が行われない場合、仮想マシンは高可用性を失います。

4.2. OpenShift virtualization のインストール

OpenShift Virtualization をインストールし、仮想化機能を OpenShift Container Platform クラスターに追加します。

インターネット接続のない制限された環境に OpenShift Virtualization をインストールする場合は、制限されたネットワーク用に Operator Lifecycle Manager (OLM) を設定 する必要があります。

インターネット接続が制限されている場合は、OLM でプロキシーサポートを設定して OperatorHub にアクセスできます。

4.2.1. OpenShift Virtualization Operator のインストール

OpenShift Container Platform Web コンソールまたはコマンドラインを使用して、OpenShift Virtualization Operator をインストールします。

4.2.1.1. Web コンソールを使用した OpenShift Virtualization Operator のインストール

OpenShift Container Platform Web コンソールを使用して、OpenShift Virtualization Operator をデプロイできます。

前提条件

- OpenShift Container Platform 4.14 をクラスターにインストールしていること。

-

cluster-adminパーミッションを持つユーザーとして OpenShift Container Platform Web コンソールにログインすること。

手順

- Administrator パースペクティブから、Operators → OperatorHub をクリックします。

- Filter by keyword に Virtualization と入力します。

- Red Hat ソースラベルが示されている OpenShift Virtualization Operator タイルを選択します。

- Operator についての情報を確認してから、Install をクリックします。

Install Operator ページで以下を行います。

- 選択可能な Update Channel オプションの一覧から stable を選択します。これにより、OpenShift Container Platform バージョンと互換性がある OpenShift Virtualization のバージョンをインストールすることができます。

インストールされた namespace の場合、Operator recommended namespace オプションが選択されていることを確認します。これにより、Operator が必須の

openshift-cnvnamespace にインストールされます。この namespace は存在しない場合は、自動的に作成されます。警告OpenShift Virtualization Operator を

openshift-cnv以外の namespace にインストールしようとすると、インストールが失敗します。Approval Strategy の場合に、stable 更新チャネルで新しいバージョンが利用可能になったときに OpenShift Virtualization が自動更新されるように、デフォルト値である Automaticを選択することを強く推奨します。

Manual 承認ストラテジーを選択することは可能ですが、クラスターのサポート容易性および機能に対応するリスクが高いため、推奨できません。これらのリスクを完全に理解していて、Automatic を使用できない場合のみ、Manual を選択してください。

警告OpenShift Virtualization は対応する OpenShift Container Platform バージョンで使用される場合にのみサポートされるため、OpenShift Virtualization が更新されないと、クラスターがサポートされなくなる可能性があります。

-

Install をクリックし、Operator を

openshift-cnvnamespace で利用可能にします。 - Operator が正常にインストールされたら、Create HyperConverged をクリックします。

- オプション: OpenShift Virtualization コンポーネントの Infra および Workloads ノード配置オプションを設定します。

- Create をクリックして OpenShift Virtualization を起動します。

検証

- Workloads → Pods ページに移動して、OpenShift Virtualization Pod がすべて Running 状態になるまでこれらの Pod をモニターします。すべての Pod で Running 状態が表示された後に、OpenShift Virtualization を使用できます。

4.2.1.2. コマンドラインを使用した OpenShift Virtualization Operator のインストール

OpenShift Virtualization カタログをサブスクライブし、クラスターにマニフェストを適用して OpenShift Virtualization Operator をインストールします。

4.2.1.2.1. CLI を使用した OpenShift Virtualization カタログのサブスクライブ

OpenShift Virtualization をインストールする前に、OpenShift Virtualization カタログにサブスクライブする必要があります。サブスクライブにより、openshift-cnv namespace に OpenShift Virtualization Operator へのアクセスが付与されます。

単一マニフェストをクラスターに適用して Namespace、OperatorGroup、および Subscription オブジェクトをサブスクライブし、設定します。

前提条件

- OpenShift Container Platform 4.14 をクラスターにインストールしていること。

-

OpenShift CLI (

oc) がインストールされている。 -

cluster-admin権限を持つユーザーとしてログインしている。

手順

以下のマニフェストを含む YAML ファイルを作成します。

apiVersion: v1 kind: Namespace metadata: name: openshift-cnv --- apiVersion: operators.coreos.com/v1 kind: OperatorGroup metadata: name: kubevirt-hyperconverged-group namespace: openshift-cnv spec: targetNamespaces: - openshift-cnv --- apiVersion: operators.coreos.com/v1alpha1 kind: Subscription metadata: name: hco-operatorhub namespace: openshift-cnv spec: source: redhat-operators sourceNamespace: openshift-marketplace name: kubevirt-hyperconverged startingCSV: kubevirt-hyperconverged-operator.v4.14.5 channel: "stable" 1- 1

stableチャネルを使用することで、OpenShift Container Platform バージョンと互換性のある OpenShift Virtualization のバージョンをインストールすることができます。

以下のコマンドを実行して、OpenShift Virtualization に必要な

Namespace、OperatorGroup、およびSubscriptionオブジェクトを作成します。$ oc apply -f <file name>.yaml

YAML ファイルで、証明書のローテーションパラメーターを設定 できます。

4.2.1.2.2. CLI を使用した OpenShift Virtualization Operator のデプロイ

oc CLI を使用して OpenShift Virtualization Operator をデプロイすることができます。

前提条件

-

openshift-cnvnamespace の OpenShift Virtualization カタログへのサブスクリプション。 -

cluster-admin権限を持つユーザーとしてログインしている。

手順

以下のマニフェストを含む YAML ファイルを作成します。

apiVersion: hco.kubevirt.io/v1beta1 kind: HyperConverged metadata: name: kubevirt-hyperconverged namespace: openshift-cnv spec:

以下のコマンドを実行して OpenShift Virtualization Operator をデプロイします。

$ oc apply -f <file_name>.yaml

検証

openshift-cnvnamespace の Cluster Service Version (CSV) のPHASEを監視して、OpenShift Virtualization が正常にデプロイされたことを確認します。以下のコマンドを実行します。$ watch oc get csv -n openshift-cnv

以下の出力は、デプロイメントに成功したかどうかを表示します。

出力例

NAME DISPLAY VERSION REPLACES PHASE kubevirt-hyperconverged-operator.v4.14.5 OpenShift Virtualization 4.14.5 Succeeded

4.2.2. 次のステップ

- ホストパスプロビジョナー は、OpenShift Virtualization 用に設計されたローカルストレージプロビジョナーです。仮想マシンのローカルストレージを設定する必要がある場合、まずホストパスプロビジョナーを有効にする必要があります。

4.3. OpenShift Virtualization のアンインストール

Web コンソールまたはコマンドラインインターフェイス (CLI) を使用して OpenShift Virtualization をアンインストールし、OpenShift Virtualization ワークロード、Operator、およびそのリソースを削除します。

4.3.1. Web コンソールを使用した OpenShift Virtualization のアンインストール

Web コンソール を使用して OpenShift Virtualization をアンインストールし、以下のタスクを実行します。

まず、すべての 仮想マシン と 仮想マシンインスタンス を削除する必要があります。

ワークロードがクラスターに残っている間は、OpenShift Virtualization をアンインストールできません。

4.3.1.1. HyperConverged カスタムリソースの削除

OpenShift Virtualization をアンインストールするには、最初に HyperConverged カスタムリソース (CR) を削除します。

前提条件

-

cluster-admin権限を持つアカウントを使用して OpenShift Container Platform クラスターにアクセスできる。

手順

- Operators → Installed Operators ページに移動します。

- OpenShift Virtualization Operator を選択します。

- OpenShift Virtualization Deployment タブをクリックします。

-

kubevirt-hyperconvergedの横にある Options メニュー をクリックし、Delete HyperConverged を選択します。

をクリックし、Delete HyperConverged を選択します。

- 確認ウィンドウで Delete をクリックします。

4.3.1.2. Web コンソールの使用によるクラスターからの Operator の削除

クラスター管理者は Web コンソールを使用して、選択した namespace からインストールされた Operator を削除できます。

前提条件

-

cluster-adminパーミッションを持つアカウントを使用して OpenShift Container Platform クラスター Web コンソールにアクセスできる。

手順

- Operators → Installed Operators ページに移動します。

- スクロールするか、キーワードを Filter by name フィールドに入力して、削除する Operator を見つけます。次に、それをクリックします。

Operator Details ページの右側で、Actions 一覧から Uninstall Operator を選択します。

Uninstall Operator? ダイアログボックスが表示されます。

Uninstall を選択し、Operator、Operator デプロイメント、および Pod を削除します。このアクションの後には、Operator は実行を停止し、更新を受信しなくなります。

注記このアクションは、カスタムリソース定義 (CRD) およびカスタムリソース (CR) など、Operator が管理するリソースは削除されません。Web コンソールおよび継続して実行されるクラスター外のリソースによって有効にされるダッシュボードおよびナビゲーションアイテムには、手動でのクリーンアップが必要になる場合があります。Operator のアンインストール後にこれらを削除するには、Operator CRD を手動で削除する必要があります。

4.3.1.3. Web コンソールを使用した namespace の削除

OpenShift Container Platform Web コンソールを使用して namespace を削除できます。

前提条件

-

cluster-admin権限を持つアカウントを使用して OpenShift Container Platform クラスターにアクセスできる。

手順

- Administration → Namespaces に移動します。

- namespace の一覧で削除する必要のある namespace を見つけます。

-

namespace の一覧の右端で、Options メニュー

から Delete Namespace を選択します。

から Delete Namespace を選択します。

- Delete Namespace ペインが表示されたら、フィールドから削除する namespace の名前を入力します。

- Delete をクリックします。

4.3.1.4. OpenShift Virtualization カスタムリソース定義の削除

Web コンソールを使用して、OpenShift Virtualization カスタムリソース定義 (CRD) を削除できます。

前提条件

-

cluster-admin権限を持つアカウントを使用して OpenShift Container Platform クラスターにアクセスできる。

手順

- Administration → CustomResourceDefinitions に移動します。

-

Label フィルターを選択し、Search フィールドに

operators.coreos.com/kubevirt-hyperconverged.openshift-cnvと入力して OpenShift Virtualization CRD を表示します。 -

各 CRD の横にある Options メニュー

をクリックし、Delete CustomResourceDefinition の削除を選択します。

をクリックし、Delete CustomResourceDefinition の削除を選択します。

4.3.2. CLI を使用した OpenShift Virtualization のアンインストール

OpenShift CLI (oc) を使用して OpenShift Virtualization をアンインストールできます。

前提条件

-

cluster-admin権限を持つアカウントを使用して OpenShift Container Platform クラスターにアクセスできる。 -

OpenShift CLI (