관리 가이드

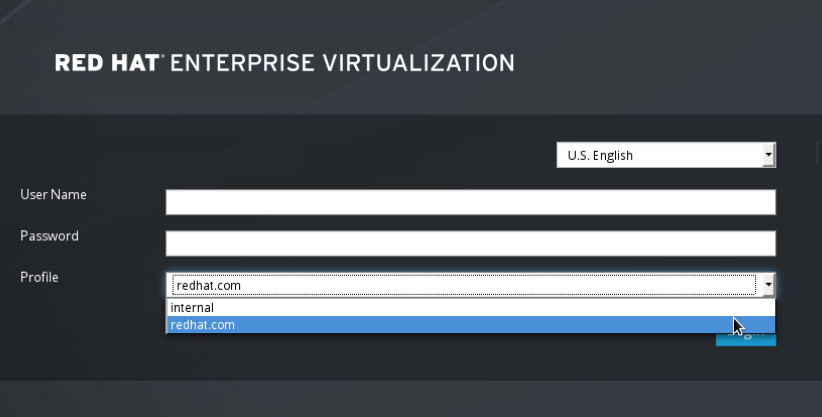

Red Hat Virtualization에서 관리 작업

법적 공지

초록

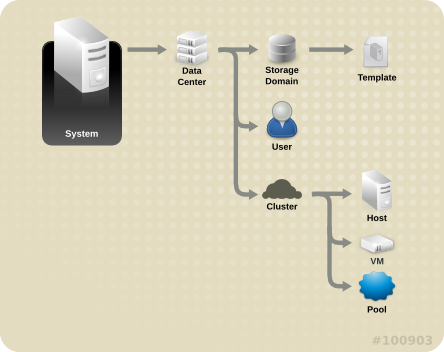

1장. Red Hat Virtualization 환경 관리 및 유지 보수

- 호스트 및 가상 머신과 같은 물리적 및 가상 리소스를 관리합니다. 이에는 호스트 업그레이드 및 추가, 도메인 가져오기, 외부 하이퍼바이저에서 생성된 가상 머신 전환, 가상 머신 풀 관리 등이 포함됩니다.

- 하나의 호스트에서 최대 부하, 메모리 또는 디스크 공간 부족과 같은 잠재적 문제에 대해 전반적인 시스템 리소스를 모니터링하고 필요한 작업 (예: 시스템을 종료하여 리소스를 사용 해제하거나 작업 부하를 줄이기 위해 다른 호스트로 가상 머신을 마이그레이션)을 실행합니다.

- 가상 머신의 새로운 요구 사항에 대응합니다. (예: 운영 체제 업그레이드 또는 더 많은 메모리 할당)

- 태그를 사용하여 사용자 정의 개체 속성을 관리합니다.

- 일반 북마크로 저장된 검색을 관리합니다.

- 사용자 설정 권한 수준을 관리합니다.

- 특정 사용자 또는 전체 시스템 기능에 대한 가상 머신의 문제를 해결합니다.

- 일반 및 특정 보고서를 생성합니다.

1.1. 전체 설정

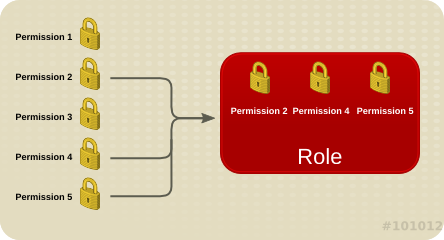

1.1.1. 역할

1.1.1.1. 새 역할 생성

절차 1.1. 새 역할 생성

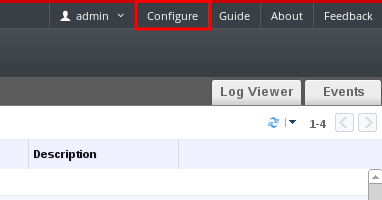

- 머리글 표시줄에서 설정 버튼을 클릭하여 설정 창을 엽니다. 이 창에는 기본 사용자와 관리자 역할 및 사용자 정의 역할 목록이 표시됩니다.

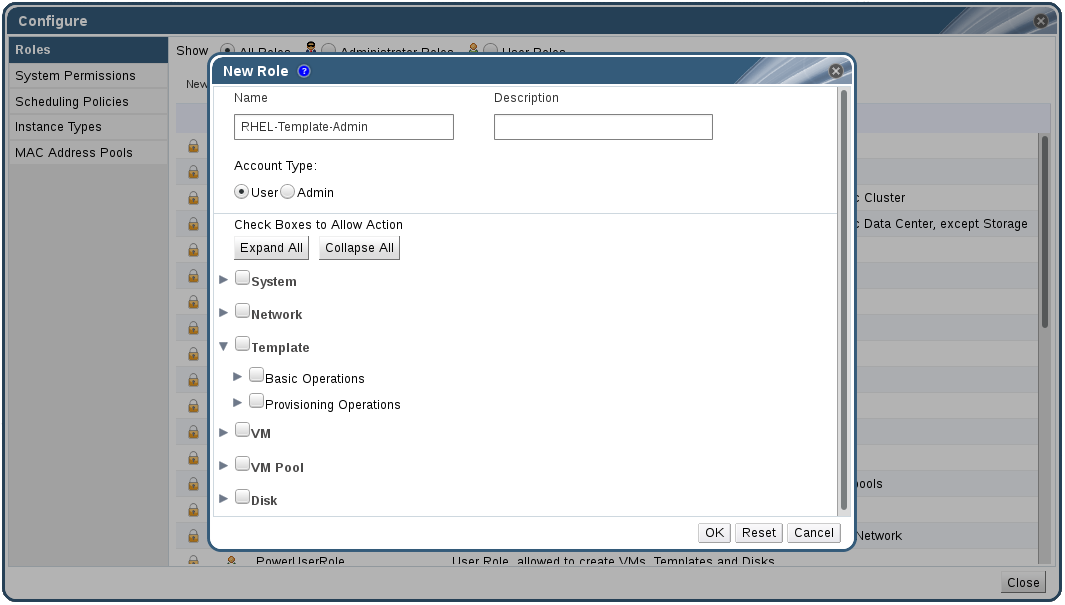

- 새로 만들기를 클릭합니다. 새 역할 창이 표시됩니다.

- 새 역할의 이름 및 설명을 입력합니다.

- 계정 유형으로 관리자 또는 사용자를 선택합니다.

- 또는 버튼을 사용하여 작업 허용을 위한 확인란 목록에 있는 개체에 대한 권한을 확장하거나 축소할 수 있습니다. 또한 각 개체에 대한 옵션을 확장하거나 축소할 수 있습니다.

- 각 개체별로 설정하려는 역할을 허용 또는 거부하고자 하는 작업을 선택 또는 선택 해제합니다.

- 를 클릭하여 변경 사항을 적용합니다. 역할 목록에 새로운 역할이 표시됩니다.

1.1.1.2. 역할 편집 또는 역할 복사

절차 1.2. 역할 편집 또는 역할 복사

- 머리글 표시줄에서 설정 버튼을 클릭하여 설정 창을 엽니다. 이 창에는 기본 사용자와 관리자 역할 및 사용자 정의 역할 목록이 표시됩니다.

- 변경하고자 하는 역할을 선택합니다. 편집을 클릭하여 역할 수정 창을 열거나 복사를 클릭하여 역할 복사 창을 엽니다.

- 필요에 따라 역할의 이름 및 설명을 변경합니다.

- 또는 버튼을 사용하여 개체에 대한 권한을 확장하거나 축소할 수 있습니다. 또한 각 개체에 대한 옵션을 확장하거나 축소할 수 있습니다.

- 각 개체별로 편집하려는 역할을 허용 또는 거부하고자 하는 작업을 선택 또는 선택 해제합니다.

- 를 클릭하여 변경 사항을 적용합니다.

1.1.1.3. 사용자 역할 및 인증 예

예 1.1. 클러스터 권한

Accounts라는 Red Hat Virtualization cluster 하에 구성되어 있습니다. 계정 클러스터에서 ClusterAdmin 역할이 Sarah에게 할당되었습니다. 가상 머신은 클러스터의 자식 개체이기 때문에 이를 통해 클러스터에 있는 모든 가상 머신을 관리할 수 있습니다. 가상 머신 관리에는 디스크와 같은 가상 리소스를 편집, 추가, 삭제하고 스냅샷을 생성하는 것 등이 포함됩니다. 하지만 클러스터 외부 리소스는 관리할 수 없습니다. ClusterAdmin은 관리자 역할이기 때문에 관리 포털을 사용하여 이러한 리소스를 관리할 수 있지만 사용자 포털을 통해 액세스할 수 없습니다.

예 1.2. VM PowerUser 권한

johndesktop이라는 가상 데스크탑을 생성했습니다. John에게는 johndesktop 가상 머신에 대해 UserVmManager 역할이 할당됩니다. 이로 인해 John은 사용자 포털을 사용하여 단일 가상 머신에 액세스할 수 있습니다. John은 UserVmManager 권한이 있기 때문에 가상 머신을 수정하거나 새 가상 디스크 등의 리소스를 추가할 수 있습니다. UserVmManager는 사용자 역할이기 때문에 관리 포털은 사용할 수 없습니다.

예 1.3. 데이터 센터 Power User Role 권한

PowerUserRole 권한이 Penelope에게 할당되었습니다. 새 가상 머신을 생성하려면 스토리지 도메인에서 가상 머신 디스크 이미지 생성과 같은 데이터 센터 내에 있는 일부 구성 요소를 변경해야 하기 때문입니다.

DataCenterAdmin 권한을 Penelope에게 할당하는 것과 동일하지 않음에 유의합니다. 데이터 센터의 PowerUser로 Penelope는 사용자 포털에 로그인하여 데이터 센터 내에 있는 가상 머신에 특정 가상 머신 작업을 수행할 수 있습니다. 하지만 데이터 센터에 호스트 또는 스토리지 연결과 같은 데이터 센터 수준의 작업은 수행할 수 없습니다.

예 1.4. 네트워크 관리자 권한

NetworkAdmin 권한이 있을 경우 데이터 센터에서 네트워크를 추가 및 삭제할 수 있으며 데이터 센터에 속한 모든 가상 머신의 네트워크를 연결 및 분리할 수 있습니다.

VnicProfileUser 권한 및 UserVmManager 권한을 할당했습니다. 이러한 권한을 사용하여 Pat는 사용자 포털의 확장 탭에서 가상 머신에 네트워크 인터페이스를 추가하는 것과 같은 단순한 관리 작업을 수행할 수 있지만 가상 머신이 실행되는 호스트의 네트워크 또는 가상 머신이 속한 데이터 센터에 있는 네트워크를 변경할 수 있는 권한이 없습니다.

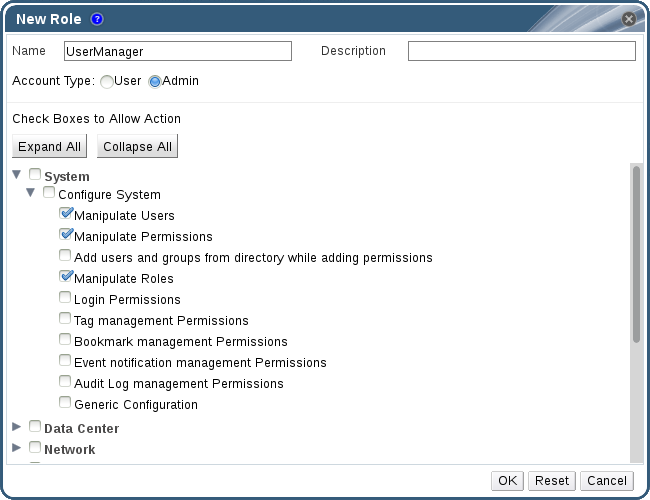

예 1.5. 사용자 정의 역할 권한

System 아래에 구성되어 있으므로 시스템에 있는 모든 다른 개체에 적용할 수 있습니다. 역할은 관리자의 계정 유형에 설정되어 있으므로 역할을 할당할 때 Rachel은 사용자 포털이 아닌 관리 포털만을 사용할 수 있습니다.

1.1.2. 시스템 권한

1.1.2.1. 사용자 속성

1.1.2.2. 사용자 및 관리자 역할

- 관리자 역할: 물리/가상 리소스를 관리하기 위해 관리 포털에 액세스할 수 있습니다. 관리자 역할에는 사용자 포털에서 실행할 수 있는 작업 권한이 부여되지만 사용자 포털에서 사용자에게 표시되는 항목을 지정할 수 없습니다.

- 사용자 역할: 가상 머신 및 템플릿에 액세스 및 관리하기 위해 사용자 포털에 액세스할 수 있습니다. 사용자 역할은 사용자 포털에서 사용자에게 표시되는 항목을 지정할 수 있습니다. 관리자 역할을 갖는 사용자에게 부여된 권한은 사용자 포털에 있는 사용자가 사용할 수 있는 작업에 반영됩니다.

administrator 역할이 있는 경우 관리 포털을 사용하여 클러스터에 있는 모든 가상 머신을 관리할 수 있지만 사용자 포털에 있는 가상 머신에 액세스할 수 없습니다. 이를 위해 user 역할이 필요합니다.

1.1.2.3. 사용자 역할

표 1.1. Red Hat Virtualization 사용자 역할 - 기본

| 역할 | 권한 | 알림 |

|---|---|---|

| UserRole | 가상 머신과 풀에 액세스 및 사용할 수 있습니다. | 사용자 포털에 로그인하여 지정된 가상 머신 및 풀을 사용하고 가상 머신 상태 및 상세 정보를 확인할 수 있습니다. |

| PowerUserRole | 가상 머신 및 템플릿을 생성 및 관리할 수 있습니다. | 설정 창을 사용하여 전체 환경에 대해 사용자에게 이 역할을 적용하거나 특정 데이터 센터 또는 클러스터에 이 역할을 적용할 수 있습니다. 예를 들어 데이터 센터 수준에서 PowerUserRole이 지정되어 있을 경우 PowerUser는 데이터 센터에 가상 머신 및 템플릿을 생성할 수 있습니다. |

| UserVmManager | 가상 머신의 시스템 관리자입니다. | 가상 머신을 관리하고 스냅샷을 생성 및 사용할 수 있습니다. 사용자 포털에서 가상 머신을 생성한 사용자에게 자동으로 시스템의 UserVmManager 역할이 할당됩니다. |

표 1.2. Red Hat Virtualization 사용자 역할 - 고급

| 역할 | 권한 | 알림 |

|---|---|---|

| UserTemplateBasedVm | 템플릿만 사용하도록 권한을 제한합니다. | 가상 머신을 생성하기 위한 템플릿을 사용할 수 있습니다. |

| DiskOperator | 가상 디스크 사용자입니다. | 가상 디스크를 사용, 보기, 편집할 수 있습니다. 가상 디스크가 연결된 가상 머신을 사용하기 위해 권한을 상속합니다. |

| VmCreator | 사용자 포털에서 가상 머신을 생성할 수 있습니다. | 이 역할은 특정 가상 머신에는 적용되지 않습니다. 설정 창을 사용하여 전체 환경에 대해 사용자에게 이 역할을 적용할 수 있습니다. 또는 특정 데이터 센터 또는 클러스터에 이 역할을 적용할 수 있습니다. 클러스터에 이 역할을 지정할 때 전체 데이터 센터나 특정 스토리지 도메인에서 DiskCreator 역할도 적용해야 합니다. |

| TemplateCreator | 지정된 리소스 내에 있는 가상 머신 템플릿을 생성, 편집, 관리, 삭제할 수 있습니다. | 이 역할은 특정 템플릿에는 적용되지 않습니다. 설정 창을 사용하여 전체 환경에 대해 사용자에게 이 역할을 적용할 수 있습니다. 또는 특정 데이터 센터, 클러스터, 스토리지 도메인에 이 역할을 적용할 수 있습니다. |

| DiskCreator | 할당된 클러스터 또는 데이터 센터에서 가상 머신 디스크를 생성, 편집, 관리, 삭제할 수 있습니다. | 이 역할은 특정 가상 디스크에는 적용되지 않습니다. 설정 창을 사용하여 전체 환경에 대한 사용자에게 이 역할을 적용할 수 있습니다. 또는 특정 데이터 센터, 스토리지 도메인에 이 역할을 적용할 수 있습니다. |

| TemplateOwner | 템플릿을 편집 및 삭제하고 템플릿의 사용자 권한을 할당 및 관리할 수 있습니다. | 이 역할은 템플릿을 생성한 사용자에게 자동으로 할당됩니다. 템플릿에서 TemplateOwner 권한이 없는 다른 사용자는 템플릿을 확인 또는 사용할 수 없습니다. |

| VnicProfileUser | 가상 머신 및 템플릿에 대한 논리 네트워크 및 네트워크 인터페이스 사용자입니다. | 특정 논리 네트워크에서 네트워크 인터페이스를 연결 또는 분리할 수 있습니다. |

1.1.2.4. 관리자 역할

표 1.3. Red Hat Virtualization 시스템 관리자 역할 - 기본

| 역할 | 권한 | 알림 |

|---|---|---|

| SuperUser | Red Hat Virtualization 환경의 시스템 관리자입니다. | 모든 개체 및 레벨에 걸쳐 완전한 권한을 가지며 모든 데이터 센터에 걸쳐 모든 개체를 관리할 수 있습니다. |

| ClusterAdmin | 클러스터 관리자입니다. | 특정 클러스터 하의 모든 개체에 대한 관리 권한을 갖습니다. |

| DataCenterAdmin | 데이터 센터 관리자입니다. | 스토리지를 제외한 특정 데이터 센터 하의 모든 개체에 대한 관리 권한을 갖습니다. |

중요

표 1.4. Red Hat Virtualization 시스템 관리자 역할 - 고급

| 역할 | 권한 | 알림 |

|---|---|---|

| TemplateAdmin | 가상 머신 템플릿의 관리자입니다. | 스토리지 도메인 및 템플릿의 네트워크 정보를 생성, 삭제, 설정하고 도메인 간에 템플릿을 이동할 수 있습니다. |

| StorageAdmin | 스토리지 관리자입니다. | 지정된 스토리지 도메인을 생성, 삭제, 설정, 관리할 수 있습니다. |

| HostAdmin | 호스트 관리자입니다. | 특정 호스트를 연결, 삭제, 설정, 관리할 수 있습니다. |

| NetworkAdmin | 네트워크 관리자입니다. | 특정 데이터 센터 또는 클러스터의 네트워크를 설정 및 관리할 수 있습니다. 데이터 센터 또는 클러스터의 네트워크 관리자는 클러스터 내의 가상 풀에 대한 네트워크 권한을 상속합니다. |

| VmPoolAdmin | 가상 풀의 시스템 관리자입니다. | 가상 풀을 생성, 삭제, 관리할 수 있습니다. 가상 풀 사용자를 지정 및 삭제하고 풀에 있는 가상 머신에서 기본 동작을 수행할 수 있습니다. |

| GlusterAdmin | Gluster 스토리지 관리자입니다. | Gluster 스토리지 볼륨을 생성, 삭제, 설정, 관리할 수 있습니다. |

| VmImporterExporter | 가상 머신의 가져오기 및 내보내기 관리자입니다. | 가상 머신을 가져오기 및 내보내기할 수 있습니다. 다른 사용자가 내보내기하는 모든 가상 머신과 템플릿을 볼 수 있습니다. |

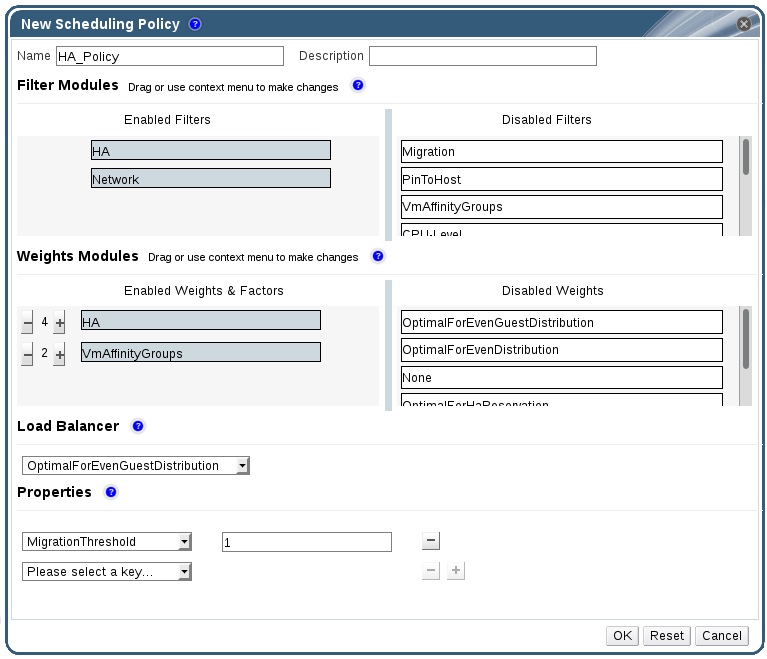

1.1.3. 스케줄링 정책

1.1.3.1. 스케줄링 정책 생성

절차 1.3. 스케줄링 정책 생성

- 관리 포털의 머리글 표시줄에 있는 버튼을 클릭하여 설정 창을 엽니다.

- 스케줄링 정책을 클릭하여 스케줄링 정책 탭을 표시합니다.

- 를 클릭하여 새 스케줄링 정책 창을 엽니다.

- 스케줄링 정책의 이름 및 설명을 입력합니다.

- 필터 모듈을 설정합니다:

- 필터 모듈 섹션의 비활성화된 필터 섹션에서 스케줄링 정책에 적용할 필터 모듈을 드래그하여 활성화된 필터 섹션에 드롭합니다.

- 특정 필터 모듈을 첫 번째로 설정하여 가장 높은 우선순위를 지정하거나 마지막으로 설정하여 가장 낮은 우선 순위로 기본 최적화할 수 있습니다.우선순위를 설정하려면 필터 모듈을 오른쪽 클릭하여 위치에 가리키면 표시되는 커서에서 첫 번째 또는 마지막을 선택합니다.

- 가중치 모듈 설정:

- 가중치 모듈 섹션의 비활성화된 가중치 섹션에서 스케줄링 정책에 적용할 가중치 모듈을 드래그하여 활성화된 가중치 및 계수 섹션에 드롭합니다.

- 활성화된 가중치 모듈 왼쪽에 있는 및 을 사용하여 해당 모듈의 가중치를 증가 또는 감소시킬 수 있습니다.

- 로드 벨런싱 정책 지정:

- 로드 밸런서 부분의 드롭 다운 메뉴에서 스케줄링 정책에 적용할 로드 밸런싱 정책을 선택합니다.

- 속성 섹션의 드롭 다운 메뉴에서 스케줄링 정책에 적용할 로드 밸런싱 속성을 선택하고 속성 오른쪽에 있는 텍스트 필드에 값을 지정합니다.

- 및 버튼을 사용하여 속성을 추가하거나 삭제합니다.

- 를 클릭합니다.

1.1.3.2. 새 스케줄링 정책 및 스케줄링 정책 편집 창 설정

표 1.5. 새 스케줄링 정책 및 스케줄링 정책 편집 설정

|

필드 이름

|

설명

|

|---|---|

|

이름

|

스케줄링 정책 이름입니다. Red Hat Virtualization Manager에서 스케줄링 정책을 참조하기 위해 사용되는 이름입니다.

|

|

설명

|

스케줄링 정책을 설명합니다. 이 필드는 권장 입력 사항이며 필수 입력 사항은 아닙니다.

|

|

필터 모듈

|

클러스터에 있는 가상 머신이 실행할 수 있는 호스트를 제어하기 위한 필터 모음입니다. 필터를 활성화하면 필터에 의해 지정된 다음과 같은 조건에 맞지 않는 호스트는 필터에서 제외됩니다:

|

|

가중치 모듈

|

가상 머신이 실행할 수 있는 클러스터에서 호스트를 지정할 때 고려할 요소의 상대적 우선순위를 제어하기 위한 가중치 모음입니다.

|

|

로드 밸런서

|

이 드롭 다운 메뉴에서는 적용할 로드 밸런싱 모듈을 선택할 수 있습니다. 로드 밸런싱 모듈은 사용률이 높은 호스트에서 사용률이 낮은 호스트로 가상 머신을 마이그레이션하기 위해 사용되는 논리를 결정합니다.

|

|

속성

|

이 드롭 다운 메뉴에서는 로드 밸런싱 모듈의 속성을 추가 또는 삭제할 수 있으며 스케줄링 정책의 로드 밸런싱 모듈을 선택한 경우에만 사용할 수 있습니다. 기본값으로 속성은 지정되어 있지 않으며 사용 가능한 속성은 선택한 로드 밸런싱 모듈에 따라 다릅니다. 및 버튼을 사용하여 로드 밸런싱 모듈에/에서 속성을 추가 또는 삭제합니다.

|

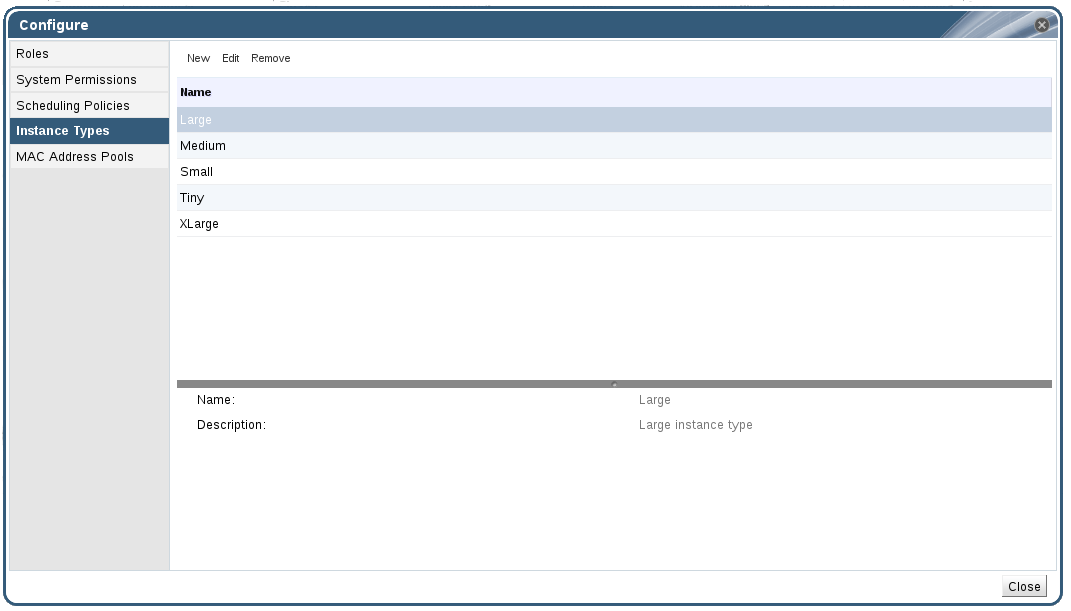

1.1.4. 인스턴스 유형

표 1.6. 사전 정의된 인스턴스 유형

|

이름

|

메모리

|

vCPU

|

|---|---|---|

|

매우 작게 (Tiny)

|

512 MB

|

1

|

|

작게 (Small)

|

2 GB

|

1

|

|

중간 (Medium)

|

4 GB

|

2

|

|

크게 (Large)

|

8 GB

|

2

|

|

아주 크게 (XLarge)

|

16 GB

|

4

|

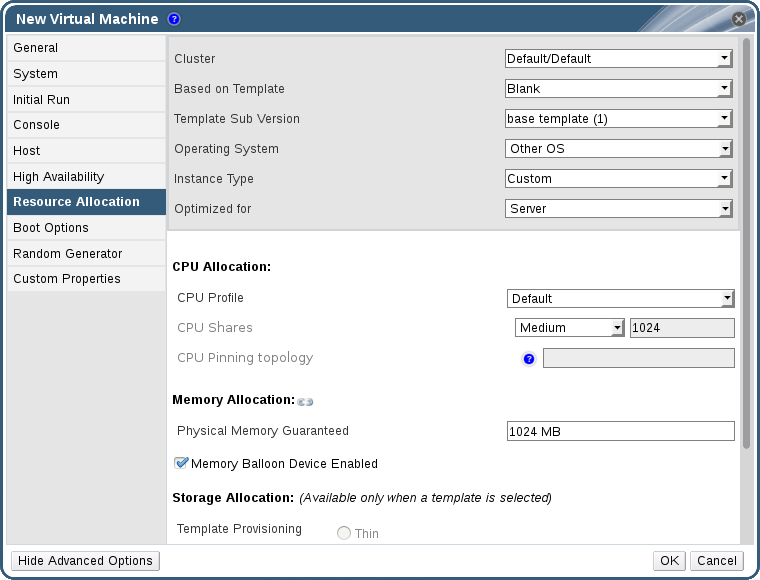

). 이 필드의 값을 변경하면 가상 머신은 인스턴스 유형에서 분리되어 사용자 정의로 변경되고 체인 링크가 분리된 이미지가 표시됩니다 (

). 이 필드의 값을 변경하면 가상 머신은 인스턴스 유형에서 분리되어 사용자 정의로 변경되고 체인 링크가 분리된 이미지가 표시됩니다 (

). 하지만 값을 다시 변경할 경우 체인 이미지는 다시 연결되어 인스턴스 유형은 선택한 인스턴스 유형으로 돌아갑니다.

). 하지만 값을 다시 변경할 경우 체인 이미지는 다시 연결되어 인스턴스 유형은 선택한 인스턴스 유형으로 돌아갑니다.

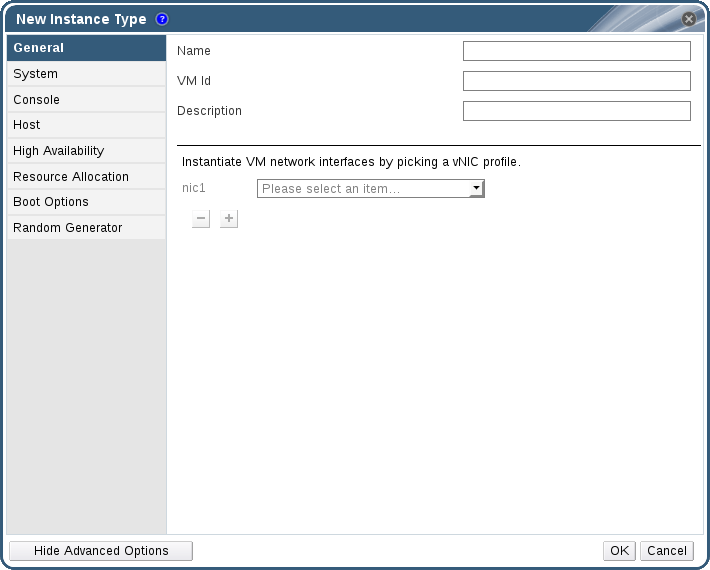

1.1.4.1. 인스턴스 유형 생성

절차 1.4. 인스턴스 유형 생성

- 머리글 표시줄에서 설정을 클릭합니다.

- 인스턴스 유형 탭을 클릭합니다.

- 버튼을 클릭하여 새 인스턴스 유형 창을 엽니다.

- 인스턴스 유형의 이름 및 설명을 입력합니다.

- 를 클릭하여 필요에 따라 인스턴스 유형을 설정합니다. 새 인스턴스 유형 창에 표시되는 설정은 새 가상 머신 창에 표시되는 내용과 동일하지만 관련 필드만 표시됩니다. 보다 자세한 내용은 Virtual Machine Management Guide에 있는 Explanation of Settings in the New Virtual Machine and Edit Virtual Machine Windows 에서 참조하십시오.

- 를 클릭합니다.

1.1.4.2. 인스턴스 유형 편집

절차 1.5. 인스턴스 유형 속성 편집

- 머리글 표시줄에서 을 클릭합니다.

- 탭을 클릭합니다.

- 편집할 인스턴스 유형을 선택합니다.

- 버튼을 클릭하여 인스턴스 유형 편집 창을 엽니다.

- 필요에 따라 설정을 변경합니다.

- 를 클릭합니다.

1.1.4.3. 인스턴스 유형 삭제

절차 1.6. 인스턴스 유형 삭제

- 머리글 표시줄에서 을 클릭합니다.

- 탭을 클릭합니다.

- 삭제할 인스턴스 유형을 선택합니다.

- 버튼을 클릭하여 인스턴스 유형 삭제 창을 엽니다.

- 가상 머신이 제거할 인스턴스 유형에 기반하는 경우 연결된 가상 머신이 나열된 경고 창이 나타납니다. 인스턴스 유형을 계속 제거하려면 승인 체크박스를 클릭합니다. 그렇지 않을 경우 를 클릭합니다.

- 를 클릭합니다.

1.1.5. MAC 주소 풀

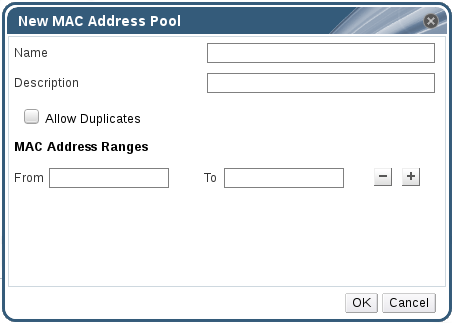

1.1.5.1. MAC 주소 풀 생성

절차 1.7. MAC 주소 풀 생성

- 머리글 표시줄에서 설정 버튼을 클릭하여 창을 엽니다.

- MAC 주소 풀 탭을 클릭합니다.

- 버튼을 클릭하여 새 MAC 주소 풀 창을 엽니다.

- 새 MAC 주소 풀의 이름 및 설명을 입력합니다.

- 중복 허용 확인란을 선택하면 MAC 주소가 풀에서 여러 번 사용됩니다. MAC 주소 풀이 중복되는 MAC 주소를 자동적으로 사용하지는 않지만 중복 허용 옵션을 활성화하면 사용자가 중복되는 MAC 주소를 수동으로 사용할 수 있습니다.

참고

하나의 MAC 주소 풀이 중복 옵션을 비활성화하고 다른 MAC 주소 풀이 중복 옵션을 활성화하면 각 MAC 주소는 중복이 비활성화된 풀에서는 한 번 사용되지만 중복이 활성화된 풀에서는 여러 번 사용될 수 있습니다. - 필요한 MAC 주소 범위를 입력합니다. 범위를 여러 개 입력하려면 범위 시작 및 범위 끝 필드 옆의 플러스 버튼을 클릭합니다.

- 를 클릭합니다.

1.1.5.2. MAC 주소 풀 편집

절차 1.8. MAC 주소 풀 속성 편집

- 머리글 표시줄에서 설정 버튼을 클릭하여 창을 엽니다.

- MAC 주소 풀 탭을 클릭합니다.

- 편집할 MAC 주소 풀을 선택합니다.

- 버튼을 클릭하여 MAC 주소 풀 편집 창을 엽니다.

- 필요에 따라 이름, 설명, 중복 허용 및 MAC 주소 범위란을 변경합니다.

참고

MAC 주소 범위가 업데이트되는 경우 기존 NIC의 MAC 주소는 재할당되지 않습니다. 이미 할당되었지만 새 MAC 주소 범위에서 벗어나는 MAC 주소는 사용자 지정 MAC 주소로 추가되며 계속해서 해당 MAC 주소 풀에서 추적됩니다. - 를 클릭합니다.

1.1.5.3. MAC 주소 풀 권한 편집

절차 1.9. MAC 주소 풀 권한 편집

- 머리글 표시줄에서 설정 버튼을 클릭하여 설정 창을 엽니다.

- MAC 주소 풀 탭을 클릭합니다.

- 필요한 MAC 주소 풀을 선택합니다.

- 해당 MAC 주소 풀의 사용자 권한을 편집합니다.

- 해당 MAC 주소 풀에 사용자 권한을 추가합니다:

- 설정 창 아래의 사용자 권한 창에 있는 추가 버튼을 누릅니다.

- 사용자를 검색 및 선택합니다.

- 할당된 역할: 드롭 다운 목록에서 역할을 선택합니다.

- OK 버튼을 클릭해서 사용자 권한을 추가합니다.

- MAC 주소 풀에서 사용자 권한을 제거합니다:

- 설정 창 아래의 사용자 권한 창에서 제거할 사용자 권한을 선택합니다.

- 제거 버튼을 클릭해서 사용자 권한을 제거합니다.

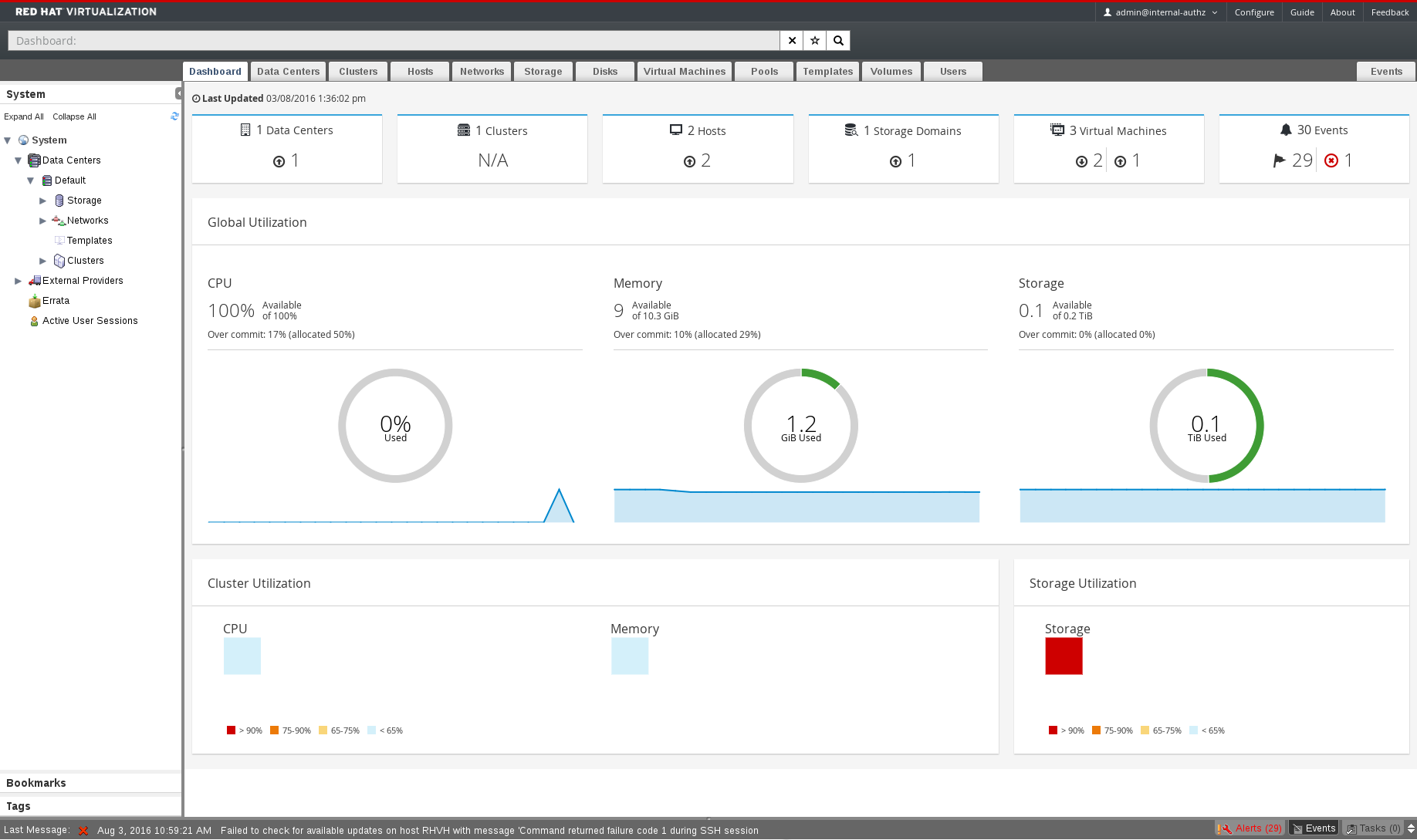

1.2. 대시보드

1.2.1. 전제 조건

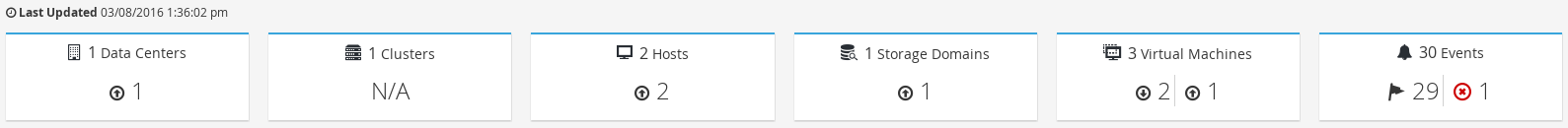

1.2.2. 전체 인벤토리

표 1.7. 리소스 상태

|

아이콘

|

상태

|

|---|---|

|

해당 리소스가 Red Hat Virtualization에 하나도 추가되지 않음.

|

|

경고 상태의 리소스 수량이 표시됩니다. 아이콘을 클릭해서 해당 탭으로 가며 검색은 경고 상태의 리소스로 제한됩니다. 각 리소스별 검색 제한 방식이 다릅니다:

|

|

실행 중인 상태인 리소스 수량이 표시됩니다. 아이콘을 클릭해서 해당 탭으로 가며 검색은 실행 중인 상태의 리소스로 제한됩니다.

|

|

정지 상태인 리소스 수량이 표시됩니다. 아이콘을 클릭해서 해당 탭으로 가며 검색은 정지 상태의 리소스로 제한됩니다. 각 리소스별 검색 제한 방식이 다릅니다:

|

|

경고 상태의 이벤트 수량이 표시됩니다. 아이콘을 클릭해서 이벤트 탭으로 가며 그 심각성이 경고 상태인 이벤트로 검색이 제한됩니다.

|

|

오류 상태의 이벤트 수량이 표시됩니다. 아이콘을 클릭해서 이벤트 탭으로 가며 그 심각성이 오류 상태인 이벤트로 검색이 제한됩니다.

|

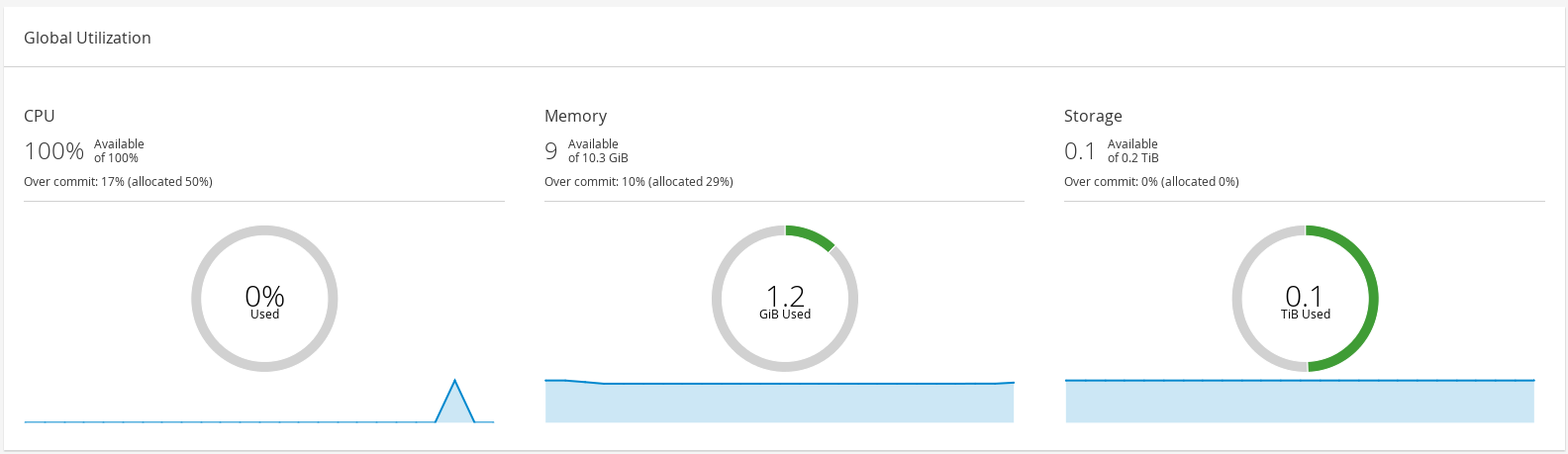

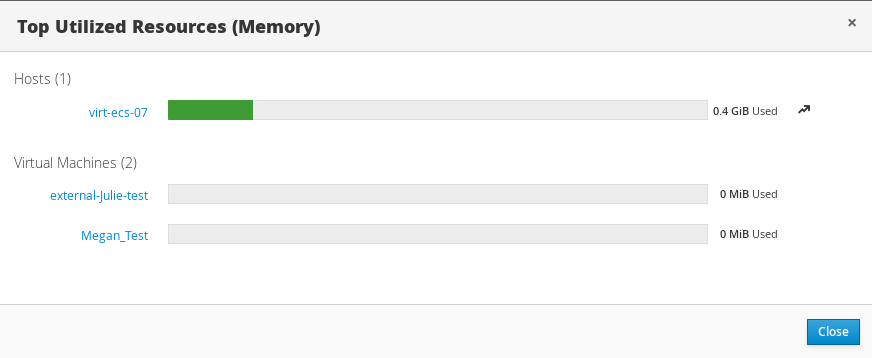

1.2.3. 전체 사용량

- 윗부분에는 사용 가능 CPU, 메모리, 스토리지 등의 백분율이 표시되며 오버 커밋 비율이 표시됩니다. 예를 들어 CPU의 오버 커밋 비율 계산 시 가상 코어 수량을 Data Warehouse의 최신 데이터를 바탕으로 가상 머신을 실행 가능한 물리 코어 수량으로 나눕니다.

- 도넛 모양에는 CPU, 메모리, 스토리지 등의 사용량이 백분율로 표시되며 최근 5분 동안의 평균 사용량을 바탕으로 모든 호스트의 평균 사용량이 표시됩니다. 도넛 모양의 어느 부분 위에 커서를 올리면 해당 부분의 값이 표시됩니다.

- 아랫부분의 선 그래프는 지난 24시간 동안의 트렌드를 보여줍니다. 각 데이터 포인트는 특정 시간의 평균 사용량을 보여줍니다. 그래프 상의 어느 부분 위에 커서를 올리면 CPU 그래프에 사용된 시간과 백분율이 표시되며 메모리 및 스토리지 그래프 사용량이 표시됩니다.

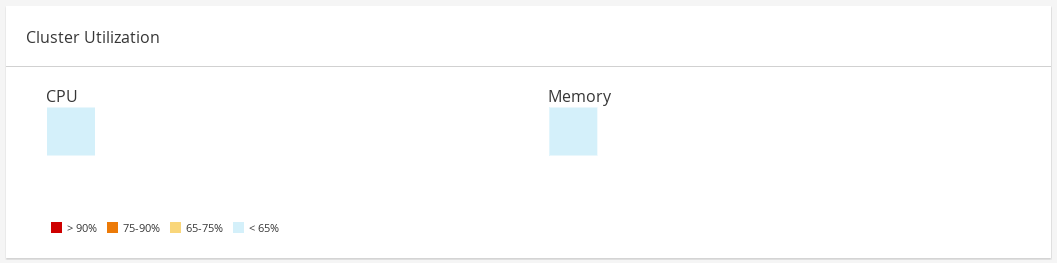

1.2.4. 클러스터 사용량

1.2.4.1. CPU

1.2.4.2. 메모리

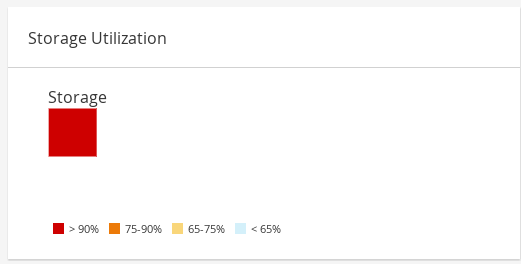

1.2.5. 스토리지 사용량

I 부. 리소스 관리

2장. QoS (Quality of Service)

2.1. 스토리지 QoS

2.1.1. 스토리지 QoS 항목 생성

절차 2.1. 스토리지 QoS 항목 생성

- 데이터 센터 리소스 탭을 클릭하고 데이터 센터를 선택합니다.

- 상세 정보 창에서 QoS를 클릭합니다.

- 스토리지를 클릭합니다.

- 를 클릭합니다.

- QoS 이름 필드에 QoS 항목 이름을 입력합니다.

- 설명 란에 QoS 항목에 대한 설명을 입력합니다.

- QoS 처리량을 지정합니다:

- 처리량 체크 상자를 선택합니다.

- 합계 란에 허용된 최대 처리량 합계를 입력합니다.

- 읽기 란에 읽기 작업에 허용되는 최대 처리량을 입력합니다.

- 쓰기 란에 쓰기 작업에 허용되는 최대 처리량을 입력합니다.

- 입력 및 출력 QoS를 지정합니다:

- IOps 체크 상자를 선택합니다.

- 합계 필드에 초당 최대 허용 입출력 작업 수를 입력합니다.

- 읽기 필드에 초당 최대 허용 입력 작업 수를 입력합니다.

- 쓰기 필드에 초당 최대 허용 출력 작업 수를 입력합니다.

- 를 클릭합니다.

2.1.2. 스토리지 QoS 항목 삭제

절차 2.2. 스토리지 QoS 항목 삭제

- 데이터 센터 리소스 탭을 클릭하고 데이터 센터를 선택합니다.

- 상세 정보 창에서 QoS를 클릭합니다.

- 스토리지를 클릭합니다.

- 삭제할 스토리지 QoS 항목을 선택합니다.

- 를 클릭합니다.

- 메세지가 나타나면 를 클릭합니다.

무제한 [unlimited]으로 설정됩니다.

2.2. 가상 머신 네트워크 QoS

2.2.1. 가상 머신 네트워크 QoS 항목 생성

절차 2.3. 가상 머신 네트워크 QoS 항목 생성

- 데이터 센터 리소스 탭을 클릭하고 데이터 센터를 선택합니다.

- 상세 정보 창에서 QoS 탭을 클릭합니다.

- 를 클릭합니다.

- 를 클릭합니다.

- 이름 필드에 가상 머신 네트워크 QoS 이름을 입력합니다.

- 인바운드 및 아웃바운드 네트워크 트래픽 제한을 입력합니다.

- 를 클릭합니다.

2.2.2. 새 가상 머신 네트워크 QoS 설정 및 가상 머신 네트워크 QoS 편집

표 2.1. 가상 머신 네트워크 QoS 설정

|

필드 이름

|

설명

|

|---|---|

|

데이터 센터

|

가상 머신 네트워크 QoS 정책이 추가되는 데이터 센터입니다. 이 필드는 선택된 데이터 센터에 따라 자동으로 설정됩니다.

|

|

이름

|

Manager 내에서 가상 머신 네트워크 QoS 정책을 표시하기 위한 이름입니다.

|

|

인바운드

|

인바운드 트래픽에 적용할 설정입니다. 이러한 설정을 활성화 또는 비활성화하려면 인바운드 확인란을 선택하거나 선택 취소합니다.

|

|

아웃바운드

|

아웃바운드 트래픽에 적용할 설정입니다. 이러한 설정을 활성화 또는 비활성화하려면 아웃바운드 확인란을 선택하거나 선택 취소합니다.

|

2.3. 호스트 네트워크 QoS

2.3.1. 호스트 네트워크 QoS 항목 생성

절차 2.5. 호스트 네트워크 QoS 항목 생성

- 데이터 센터 리소스 탭을 클릭하고 데이터 센터를 선택합니다.

- 상세 정보 창에서 QoS를 클릭합니다.

- 호스트 네트워크를 클릭합니다.

- 를 클릭합니다.

- QoS 이름 필드에 QoS 항목 이름을 입력합니다.

- 설명 란에 QoS 항목에 대한 설명을 입력합니다.

- 가중 공유, 속도 제한 [Mbps], and 커밋 속도 [Mbps] 항목에 원하는 값을 입력합니다.

- 를 클릭합니다.

2.3.2. 새 호스트 네트워크 QoS 설정 및 호스트 네트워크 QoS 편집

표 2.2. 호스트 네트워크 QoS 설정

|

필드 이름

|

설명

|

|---|---|

|

데이터 센터

|

호스트 네트워크 QoS 정책이 추가되는 데이터 센터입니다. 이 필드는 선택된 데이터 센터에 따라 자동으로 설정됩니다.

|

|

QoS 이름

|

Manager 내에서 호스트 네트워크 QoS 정책을 표시하기 위한 이름입니다.

|

|

설명

|

호스트 네트워크 QoS 정책에 대한 설명입니다.

|

|

아웃바운드

|

아웃바운드 트래픽에 적용할 설정입니다.

|

2.4. CPU QoS (Quality of Service)

2.4.1. CPU QoS 항목 생성

절차 2.7. CPU QoS 항목 생성

- 데이터 센터 리소스 탭을 클릭하고 데이터 센터를 선택합니다.

- 상세 정보 창에서 QoS를 클릭합니다.

- CPU를 클릭합니다.

- 를 클릭합니다.

- QoS 이름 필드에 QoS 항목 이름을 입력합니다.

- 설명 란에 QoS 항목에 대한 설명을 입력합니다.

- 제한 필드에서 백분율로 QoS 최대 처리 용량을 입력합니다.

%기호를 입력하지 않습니다. - 를 클릭합니다.

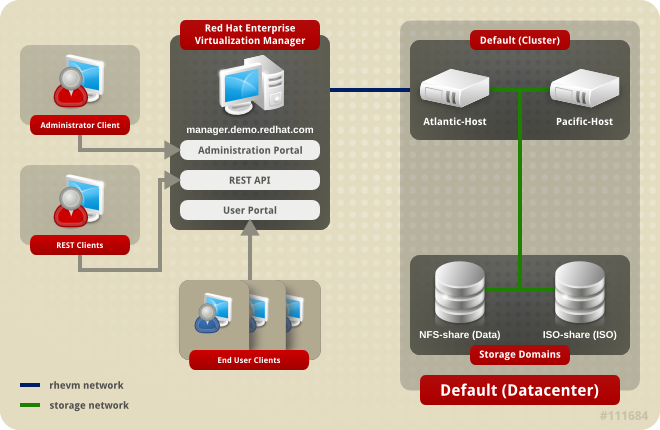

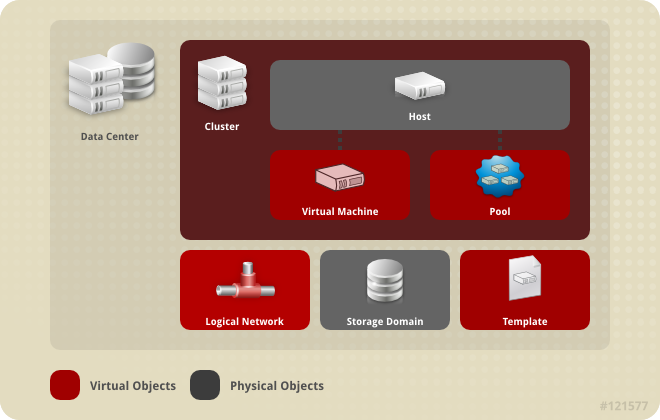

3장. 데이터 센터

3.1. 데이터 센터 소개

3.2. SPM (Storage Pool Manager)

3.3. SPM 우선순위

3.4. 이벤트 탭을 사용하여 데이터 센터에서 문제가 있는 개체를 식별

3.5. 데이터 센터 작업

3.5.1. 새 데이터 센터 생성

참고

절차 3.1. 새 데이터 센터 생성

- 데이터 센터 리소스 탭을 선택하여 결과 목록에 모든 데이터 센터를 나열합니다.

- 를 클릭하여 새로운 데이터 센터 창을 엽니다.

- 데이터 센터의 이름 및 설명을 입력합니다.

- 드롭 다운 메뉴에서 데이터 센터의 스토리지 유형, 호환 버전, 쿼터 모드를 선택합니다.

- 옵션으로 데이터 센터의 MAC 주소 풀을 변경합니다. 기본 MAC 주소 풀은 기본값으로 미리 선택됩니다. MAC 주소 풀 생성에 대한 자세한 정보는 1.1.5절. “MAC 주소 풀”을 참조하시기 바랍니다.

- MAC 주소 풀 탭을 클릭합니다.

- MAC 주소 풀 드롭 다운 목록에서 필요한 MAC 주소 풀을 선택합니다.

- 를 클릭하여 데이터 센터를 생성하고 데이터 센터 - 가이드 창을 엽니다.

- 가이드 창에는 데이터 센터 설정에 필요한 엔티티가 나열됩니다. 이러한 엔티티를 설정하거나 버튼을 클릭하여 나중에 설정합니다. 설정을 다시 시작하려면 데이터 센터를 선택하고 버튼을 클릭합니다.

3.5.2. 새 데이터 센터 및 데이터 센터 편집 창 설정

표 3.1. 데이터 센터 속성

|

필드

|

설명/동작

|

|---|---|

|

이름

|

데이터 센터 이름입니다. 텍스트 필드는 최대 40 자로 제한되어 있으며 알파벳 대문자, 소문자, 숫자, 하이픈, 밑줄로 조합된 고유한 이름이어야 합니다.

|

|

설명

| 데이터 센터 설명입니다. 이는 권장 사항이며 필수 입력 사항은 아닙니다. |

|

유형

|

스토리지 유형입니다. 다음 중 하나를 선택합니다:

데이터 도메인 유형에 따라 데이터 센터 유형을 지정하고 생성 후 서비스가 중단될 수 있으므로 수정하지 않습니다. 로컬 도메인과 공유 도메인을 혼합할 수 없지만 여러 유형의 스토리지 도메인 (iSCSI, NFS, FC, POSIX, Gluster)을 동일한 데이터 센터에 추가할 수 있습니다.

|

|

호환성 버전

|

Red Hat Virtualization 버전입니다. 다음 중 하나를 선택합니다:

|

|

쿼터 모드

| 쿼터는 Red Hat Virtualization에 제공되는 리소스 제한 도구입니다. 다음 중 하나를 선택합니다:

|

|

MAC 주소 풀

|

데이터 센터의 MAC 주소 풀입니다. 다른 MAC 주소 풀을 할당하지 않으면 기본 MAC 주소 풀이 사용됩니다. MAC 주소 풀에 대한 자세한 정보는 1.1.5절. “MAC 주소 풀”을 참조하시기 바랍니다.

|

3.5.3. 데이터 센터 재초기화: 복구 절차

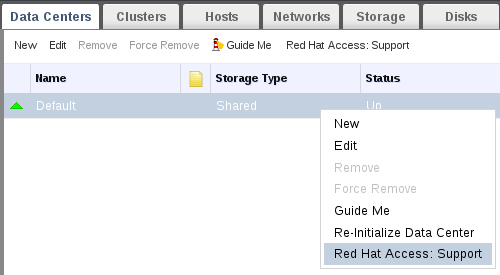

절차 3.2. 데이터 센터 재초기화

- 데이터 센터 리소스 탭을 클릭하여 재초기화할 데이터 센터를 선택합니다.

- 데이터 센터에 연결된 스토리지 도메인이 유지 관리 모드인지를 확인합니다.

- 데이터 센터를 오른쪽 클릭하고 드롭 다운 메뉴에서 데이터 센터의 재 초기화를 선택하여 데이터 센터의 재 초기화 창을 엽니다.

- 데이터 센터의 재 초기화 창에는 모든 사용 가능한 스토리지 도메인 목록이 표시됩니다. 데이터 센터에 추가하려는 스토리지 도메인의 라디오 버튼을 클릭합니다.

- 작업 승인 확인란을 선택합니다.

- 를 클릭하여 창을 닫고 데이터 센터를 다시 초기화합니다.

3.5.4. 데이터 센터 삭제

절차 3.3. 데이터 센터 삭제

- 데이터 센터에 연결된 스토리지 도메인이 유지 관리 모드인지를 확인합니다.

- 데이터 센터 리소스 탭을 클릭하여 삭제할 데이터 센터를 선택합니다.

- 를 클릭하여 데이터 센터 삭제 확인 창을 엽니다.

- 를 클릭합니다.

3.5.5. 데이터 센터 강제 삭제

Non Responsive 상태일 경우 데이터 센터는 Non Responsive 상태가 됩니다. 이러한 상태에서는 데이터 센터를 삭제할 수 없습니다.

절차 3.4. 데이터 센터 강제 삭제

- 데이터 센터 리소스 탭을 클릭하여 삭제할 데이터 센터를 선택합니다.

- 강제 삭제를 클릭하여 데이터 센터 강제 삭제 확인 창을 엽니다.

- 작업 승인 확인란을 선택합니다.

- OK를 클릭합니다.

3.5.6. 데이터 센터 호환 버전 변경

참고

절차 3.5. 데이터 센터 호환 버전 변경

- 관리 포털에서 데이터 센터 탭을 클릭합니다.

- 표시된 목록에서 변경하려는 데이터 센터를 선택합니다.

- 을 클릭합니다.

- 호환 버전을 원하는 값으로 변경합니다.

- 를 클릭하여 데이터 센터 호환 버전 변경 확인 창을 엽니다.

- 를 클릭하여 확인합니다.

중요

3.6. 데이터 센터 및 스토리지 도메인

3.6.1. 데이터 센터에 기존 데이터 도메인 연결

절차 3.6. 데이터 센터에 기존 데이터 도메인 연결

- 데이터 센터 리소스 탭을 클릭하여 적절한 데이터 센터를 선택합니다.

- 상세 정보 창에서 스토리지 탭을 선택하여 데이터 센터에 이미 연결된 스토리지 도메인 목록을 나열합니다.

- 을 클릭하여 스토리지 연결 창을 엽니다.

- 데이터 센터에 연결하려는 데이터 도메인의 확인란을 선택합니다. 확인란을 여러개 선택하여 여러 데이터 도메인을 연결할 수 있습니다.

- 를 클릭합니다.

3.6.2. 데이터 센터에 기존 ISO 도메인 연결

절차 3.7. 데이터 센터에 기존 ISO 도메인 연결

- 데이터 센터 리소스 탭을 클릭하여 해당하는 데이터 센터를 선택합니다.

- 상세 정보 창에서 스토리지 탭을 선택하여 데이터 센터에 이미 연결된 스토리지 도메인 목록을 나열합니다.

- 을 클릭하여 ISO 라이브러리 연결 창을 엽니다.

- 해당 ISO 도메인의 라디오 버튼을 클릭합니다.

- 를 클릭합니다.

3.6.3. 기존 내보내기 도메인을 데이터 센터에 연결

참고

절차 3.8. 기존 내보내기 도메인을 데이터 센터에 연결

- 데이터 센터 리소스 탭을 클릭하여 적절한 데이터 센터를 선택합니다.

- 상세 정보 창에서 스토리지 탭을 선택하여 데이터 센터에 이미 연결된 스토리지 도메인 목록을 나열합니다.

- 을 클릭하면 내보내기 도메인 연결 창이 열립니다.

- 해당 내보내기 도메인의 라디오 버튼을 클릭합니다.

- 를 클릭합니다.

3.6.4. 데이터 센터에서 스토리지 도메인 분리

참고

절차 3.9. 데이터 센터에서 스토리지 도메인 분리

- 데이터 센터 리소스 탭을 클릭하여 해당하는 데이터 센터를 선택합니다.

- 상세 정보 창에서 스토리지 탭을 선택하여 데이터 센터에 연결된 스토리지 도메인 목록을 나열합니다.

- 분리할 스토리지 도메인을 선택합니다. 스토리지 도메인이

Active상태일 경우 를 클릭하여 스토리지 도메인 유지 관리 확인 창을 엽니다. - 를 클릭하여 유지 관리 모드를 시작합니다.

- 를 클릭하여 스토리지 분리 확인창을 엽니다.

- 를 클릭합니다.

3.7. 데이터 센터 및 권한

3.7.1. 데이터 센터의 시스템 권한 관리

- 데이터 센터와 관련된 클러스터를 생성 및 삭제합니다.

- 데이터 센터와 관련된 호스트, 가상 머신, 풀을 추가 및 삭제합니다.

- 데이터 센터와 관련된 가상 머신의 사용자 권한을 편집합니다.

참고

3.7.2. 데이터 센터 관리자 역할

표 3.2. Red Hat Virtualization 시스템 관리자 역할

| 역할 | 권한 | 알림 |

|---|---|---|

| DataCenterAdmin | 데이터 센터 관리자 | 스토리지를 제외하고 클러스터, 호스트, 템플릿, 가상 머신을 포함하여 특정 데이터 센터에 있는 모든 물리적 및 가상 리소스를 사용, 생성, 삭제, 관리할 수 있습니다. |

| NetworkAdmin | 네트워크 관리자 | 특정 데이터 센터의 네트워크를 설정 및 관리할 수 있습니다. 데이터 센터의 네트워크 관리자는 데이터 센터 내의 가상 머신에 대한 네트워크 권한을 상속합니다. |

3.7.3. 리소스에 관리자 또는 사용자 역할 할당

절차 3.10. 리소스에 역할 할당

- 리소스 탭, 트리 모드 또는 검색 기능을 사용하여 검색 결과 목록에서 리소스를 검색 및 선택합니다.

- 상세 정보 창에 있는 탭을 클릭하여 할당된 사용자, 사용자 역할, 선택한 리소스에 대해 상속된 권한을 나열합니다.

- 를 클릭합니다.

- 검색 텍스트 상자에 기존 사용자의 이름 또는 사용자 이름을 입력하고 을 클릭합니다. 검색 결과 목록에서 일치하는 사용자를 선택합니다.

- 할당된 역할: 드롭 다운 목록에서 역할을 선택합니다.

- 를 클릭합니다.

3.7.4. 리소스에서 관리자 또는 사용자 역할 삭제

절차 3.11. 리소스에서 역할 삭제

- 리소스 탭, 트리 모드 또는 검색 기능을 사용하여 검색 결과 목록에서 리소스를 검색 및 선택합니다.

- 상세 정보 창에 있는 탭을 클릭하여 할당된 사용자 목록, 사용자 역할, 선택한 리소스에서 상속된 권한을 나열합니다.

- 리소스에서 삭제할 사용자를 선택합니다.

- 를 클릭합니다. 권한 삭제 창이 열리면 권한 삭제를 확인합니다.

- 를 클릭합니다.

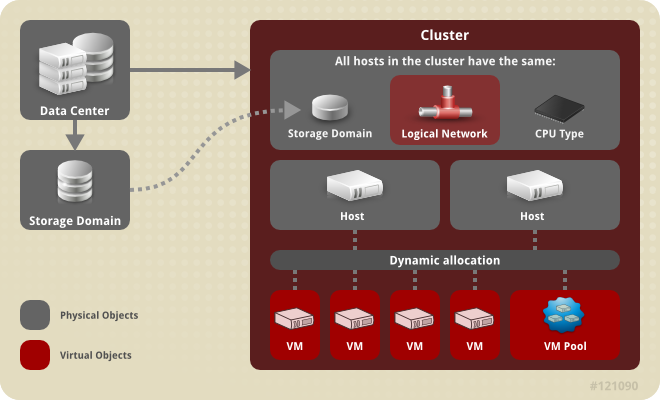

4장. 클러스터

4.1. 클러스터에 대한 소개

4.2. 클러스터 작업

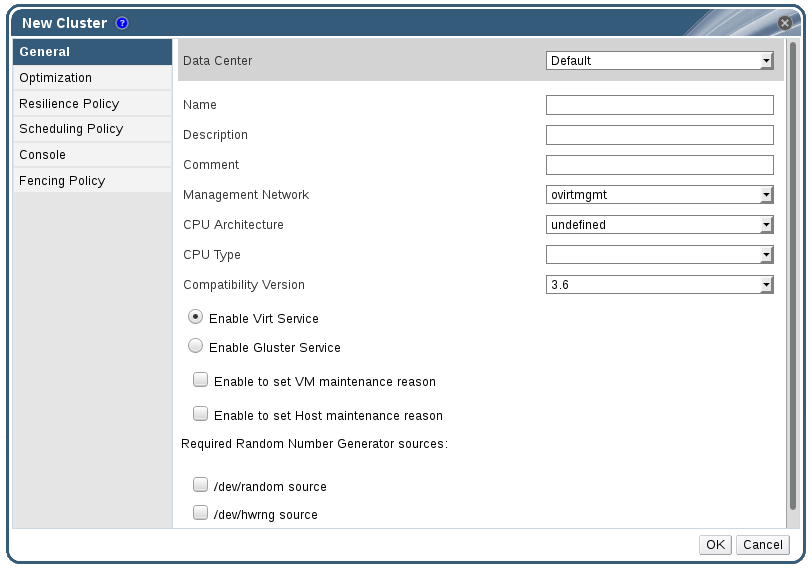

4.2.1. 새 클러스터 생성

절차 4.1. 새 클러스터 생성

- 클러스터 리소스 탭을 선택합니다.

- 를 클릭합니다.

- 드롭 다운 목록에서 클러스터가 속할 데이터 센터를 선택합니다.

- 클러스터의 이름 및 설명을 입력합니다.

- 관리 네트워크 드롭 다운 목록에서 네트워크를 선택하고 관리 네트워크 역할을 지정합니다.

- 드롭 다운 목록에서 CPU 아키텍처 및 CPU 유형을 선택합니다. CPU 프로세스 제품군과 클러스터에 연결하고자 하는 호스트의 최소 CPU 프로세서 유형과 일치해야 합니다. 그렇지 않을 경우 호스트는 작동하지 않게 됩니다.

참고

Intel과 AMD CPU 유형 모두의 경우 CPU 모델은 오래된 것 부터 가장 최신의 논리적 순서로 나열됩니다. 클러스터에 다른 CPU 모델이 있는 호스트가 포함되어 있을 경우 오래된 CPU 모델을 선택합니다. 각 CPU 모델에 대한 보다 자세한 내용은 https://access.redhat.com/solutions/634853에서 참조하십시오. - 드롭 다운 목록에서 클러스터의 호환 버전을 선택합니다.

- Virt 서비스 활성화 또는 Gluster 서비스 활성화 라디오 버튼을 선택하여 클러스터를 가상 머신 호스트 또는 Gluster 활성 노드로 배포할지 여부를 지정합니다. Red Hat Virtualization Host(RHVH)를 Gluster 활성 클러스터에 추가할 수 없음에 유의합니다.

- 가상 머신 유지 보수 이유 설정을 활성화 옵션을 선택하여 가상 머신이 Manager에서 종료 시 이유 설정 옵션을 사용하여 관리자가 유지 관리에 대한 설명을 제공할 수 있게 합니다.

- 호스트 유지 보수 이유 설정을 활성화 옵션을 선택하여 호스트가 Manager에서 유지 관리 모드로 전환 시 이유 설정 옵션을 사용하여 관리자가 유지 관리에 대한 설명을 제공할 수 있게 합니다.

- /dev/random source (Linux 제공 장치) 또는 /dev/hwrng source (외부 하드웨어 장치)란을 선택하여 클러스터에 있는 모든 호스트가 사용할 난수 생성기를 지정합니다.

- 최적화 탭을 클릭하여 클러스터의 메모리 페이지 공유 임계값을 선택하고 클러스터에 있는 호스트에서 CPU 스레드 처리 및 메모리 부울 옵션을 활성화합니다.

- 마이그레이션 정책 탭을 클릭하여 클러스터의 가상 머신 마이그레이션 정책을 지정합니다.

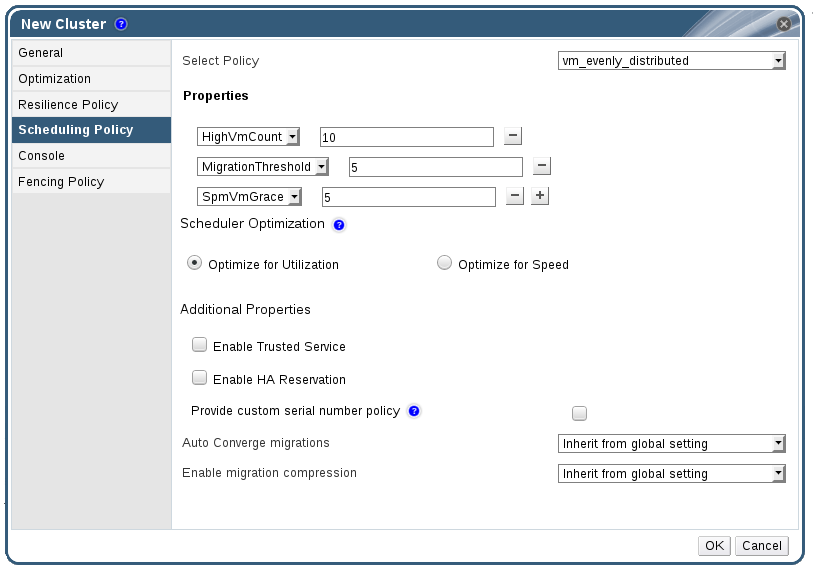

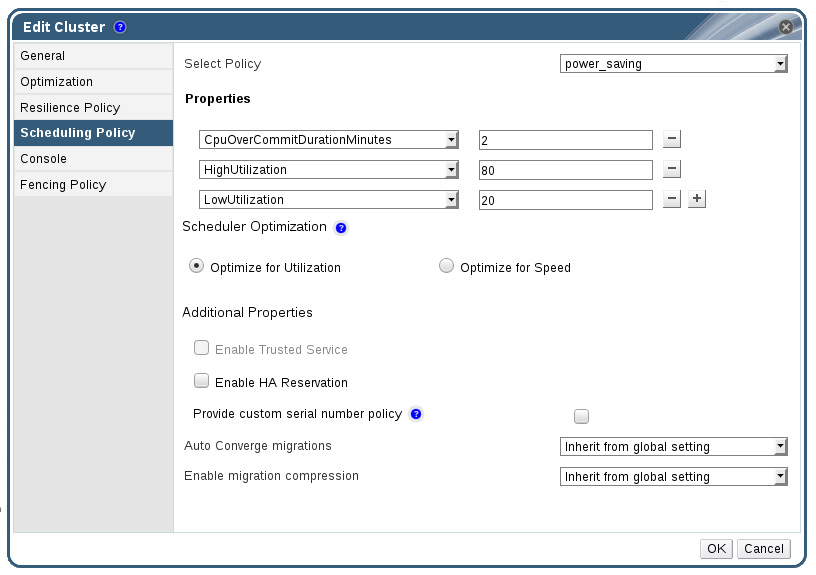

- 스케줄링 정책 탭을 클릭하여 스케줄링 정책 설정, 스케줄러 최적화 설정, 클러스터에 있는 호스트의 신뢰할 수 있는 서비스 활성화, HA 예약 활성화,사용자 정의 일련 번호 정책 추가와 같은 옵션을 설정합니다.

- 콘솔 탭을 클릭하여 글로벌 SPICE 프록시를 덮어쓰기하고 클러스터에 있는 호스트의 SPICE 프록시 주소를 지정합니다.

- 펜싱 정책 탭을 클릭하여 클러스터의 펜싱을 활성화 또는 비활성화하고 펜싱 옵션을 선택합니다.

- 를 클릭하여 클러스터를 생성하고 새 클러스터 - 가이드 창을 엽니다.

- 가이드 창에는 클러스터 설정에 필요한 엔티티가 나열됩니다. 이러한 엔티티를 설정하거나 버튼을 클릭하여 나중에 설정합니다. 설정을 다시 시작하려면 클러스터를 선택하고 버튼을 클릭합니다.

4.2.2. 새 클러스터 및 클러스터 편집 창 설정 및 제어

4.2.2.1. 일반 클러스터 설정

표 4.1. 일반 클러스터 설정

|

필드

|

설명/동작

|

|---|---|

|

데이터 센터

|

데이터 센터에는 클러스터가 포함되어 있습니다. 데이터 센터는 클러스터를 추가하기 전에 생성해야 합니다.

|

|

이름

|

클러스터 이름입니다. 텍스트 필드는 최대 40 자로 제한되어 있으며 알파벳 대문자, 소문자, 숫자, 하이픈, 밑줄로 조합된 고유한 이름이어야 합니다.

|

|

설명 / 코멘트

| 클러스터 설명 또는 추가 알림 내용입니다. 이는 권장 사항이며 필수 입력 사항은 아닙니다. |

|

관리 네트워크

|

관리 네트워크 역할을 할당할 논리 네트워크입니다. 기본값은 ovirtmgmt입니다. 기존 클러스터에서 관리 네트워크는 상세 정보 창에서 논리 네트워크 탭에 있는 버튼을 통해서만 변경될 수 있습니다.

|

| CPU 아키텍처 | 클러스터의 CPU 아키텍처입니다. 선택된 CPU 아키텍처에 따라 다른 CPU 유형을 사용할 수 있습니다.

|

|

CPU 유형

| 클러스터의 CPU 유형입니다. 다음 중 하나를 선택합니다:

|

|

호환성 버전

| Red Hat Virtualization 버전입니다. 다음 중 하나를 선택합니다:

|

|

Virt 서비스 활성화

| 라디오 버튼이 선택되어 있을 경우 클러스터에 있는 호스트는 가상 머신을 실행하는데 사용됩니다. |

|

Gluster 서비스 활성화

| 라디오 버튼이 선택되어 있을 경우 클러스터에 있는 호스트는 Red Hat Gluster Storage Server 노드로 사용되고 가상 머신을 실행하지 않게 됩니다. Red Hat Virtualization Host를 이러한 옵션이 활성화된 클러스터에 추가할 수 없습니다. |

|

기존 Gluster 설정 가져오기

|

다음 확인란은 Gluster 서비스 활성화 라디오 버튼이 선택되어 있을 경우에만 사용할 수 있습니다. 이 옵션을 통해 기존 Gluster 활성 클러스터 및 Red Hat Virtualization Manager에 연결된 모든 호스트를 가져올 수 있습니다.

다음 옵션은 가져오기할 클러스터에 있는 각 호스트에 필요합니다:

|

| 가상 머신 유지 관리 이유 설정 활성화 | 이 확인란이 선택되어 있는 경우 클러스터에 있는 가상 머신을 Manager에서 종료할 때 이유를 입력할 수 있는 필드가 표시됩니다. 이를 통해 유지 관리 이유를 입력하면 가상 머신 전원이 다시 켜졌을 때 로그에 표시됩니다. |

| 호스트 유지 관리 이유 설정 활성화 | 이 확인란이 선택되어 있는 경우 클러스터에 있는 호스트를 Manager에서 유지 관리 모드로 전환하면 이유를 입력할 수 있는 필드가 표시됩니다. 이를 통해 유지 관리 이유를 입력하면 호스트가 다시 활성화되었을 때 로그에 표시됩니다. |

| 필요한 난수 생성기 소스: |

다음 중 하나의 확인란이 선택되어 있을 경우 클러스터에 있는 모든 호스트는 해당 장치를 사용할 수 있어야 합니다. 이는 난수 생성기에서 가상 머신으로 엔트로피를 전달할 수 있습니다.

|

4.2.2.2. 최적화 설정

표 4.2. 최적화 설정

|

필드

|

설명/동작

|

|---|---|

|

메모리 최적화

|

|

|

CPU 스레드

|

스레드를 코어로 계산 확인란을 선택하여 호스트가 호스트에 있는 코어 수를 초과하는 총 프로세서 코어 수로 가상 머신을 실행합니다.

표시된 호스트 스레드는 코어로 처리되며 가상 머신에서 활용할 수 있습니다. 예를 들어 코어 당 2 개의 스레드가 있는 24 코어 시스템 (총 48 스레드)의 경우 각각 최대 48 코어로 가상 머신을 실행할 수 있으며 호스트 CPU 부하를 산출하는 알고리즘은 2 배의 사용 가능한 코어로 부하를 비교하게 됩니다.

|

|

메모리 Balloon

|

메모리 Balloon 최적화 활성화 확인란을 선택하여 클러스터에 있는 호스트에서 실행되는 가상 머신의 메모리 오버커밋을 활성화합니다. 이 옵션을 설정하면 MoM (Memory Overcommit Manager)은 각 가상 머신에 확보된 메모리 크리를 제한하여 메모리 ballooning을 시작합니다.

메모리 ballooning을 시작하려면 가상 머신에 적절한 드라이버와 함께 balloon 장치가 필요합니다. 각 가상 머신에는 삭제하지 않는 한 balloon 장치가 포함되어 있습니다. 이러한 클러스터에 있는 각 호스트는 클러스터가 상태가

Up으로 변경되면 balloon 정책 업데이트를 받을 수 있습니다. 필요한 경우 상태를 변경하지 않고 호스트에 있는 balloon 정책을 수동으로 업데이트할 수 있습니다. 보다 자세한 내용은 4.2.5절. “클러스터에 있는 호스트에서 MoM 정책 업데이트”에서 참조하십시오.

일부 시나리오에서는 메모리 ballooning으로 인해 KSM과 충돌할 수 있음을 이해하고 있어야 합니다. 이러한 경우 MoM은 충돌을 최소화하기 위해 balloon 크기를 조정하게 됩니다. 또한 일부 시나리오에서는 메모리 ballooning으로 인해 가상 머신의 성능이 최적화되지 않을 수 있습니다. 관리자는 신중하게 ballooning 최적화를 사용해야 합니다.

|

|

KSM 컨트롤

|

KSM 활성화 확인란을 선택하여 CPU 비용을 초과하는 메모리 저장에서 높은 혜택을 얻을 경우 MoM이 활성화하여 KSM (Kernel Same-page Merging)을 실행합니다.

|

4.2.2.3. 마이그레이션 정책 설정

표 4.3. 마이그레이션 정책

|

정책

|

설명

|

|---|---|

|

Legacy

|

3.6 버전의 레거시 동작입니다.

vdsm.conf의 덮어쓰기는 여전히 적용됩니다. 게스트 에이전트 후크 메커니즘은 비활성화됩니다.

|

|

Minimal downtime

|

일반적인 상황에서 가상 머신 마이그레이션을 할 수 있게 해주는 정책입니다. 가상 머신의 다운 타임은 길지 않습니다. 가상 머신 마이그레이션이 오랫동안 (QEMU 반복에 따라 최대 500 밀리초까지) 수렴되지 않는 경우 마이그레이션이 중단됩니다. 게스트 에이전트 후크 메커니즘은 활성화됩니다.

|

|

Suspend workload if needed

|

대부분의 상황에서 가상 머신 마이그레이션을 할 수 있게 해주는 정책이며, 가상 머신이 많은 작업량을 실행하는 경우를 포함합니다. 가상 머신의 다운 타임이 길 수 있습니다. 최대 부하 시 마이그레이션이 중단될 수도 있습니다. 게스트 에이전트 후크 메커니즘은 활성화됩니다.

|

표 4.4. 대역폭

|

정책

|

설명

|

|---|---|

|

Auto

|

데이터 센터 호스트 네트워크 QoS의 속도 제한 [Mbps] 설정에서 대역폭이 복사됩니다. 제한 속도를 설정하지 않은 경우 네트워크 인터페이스의 송수신 최소 연결 속도로 계산됩니다. 제한 속도가 설정되지 않고 사용 가능한 연결 속도가 없는 경우 제한 속도는 보내는 호스트의 로컬 VDSM 설정에 따라 결정됩니다.

|

|

Hypervisor default

|

대역폭은 보내는 호스트의 로컬 VDSM 설정에 따라 결정됩니다.

|

|

Custom

|

사용자가 지정합니다. (단위: Mbps)

|

표 4.5. 복구 정책 설정

|

필드

|

설명/동작

|

|---|---|

|

가상 머신을 마이그레이션함

|

가상 머신을 설정된 우선순위 순서대로 마이그레이션합니다.

|

|

고가용성 가상 머신만 마이그레이션

|

고가용성 가상 머신만 마이그레이션하여 다른 호스트가 오버로딩되지 않게 합니다.

|

|

가상 머신은 마이그레이션 하지 않음

| 가상 머신이 마이그레이션되지 않게 합니다. |

표 4.6. 추가 속성

|

속성

|

설명

|

|---|---|

|

마이그레이션 자동 통합

|

가상 머신의 라이브 마이그레이션 중 자동 컨버전스를 사용할지에 대한 여부를 설정합니다. 워크로드가 큰 대형 가상 머신은 라이브 마이그레이션 중 전송 속도 보다 더 빠르게 더티 메모리 상태가 되어 마이그레이션을 컨버전스하지 못하게 합니다. QEMU의 자동 컨버전스 기능을 통해 가상 머신 마이그레이션 컨버전스를 강제할 수 있습니다. QEMU는 자동으로 컨버전스되지 않음을 감지하고 가상 머신에 있는 vCPU의 스로틀을 감소시킵니다. 자동 컨버전스는 전역에서 기본값으로 비활성화되어 있습니다.

|

|

마이그레이션 압축 활성화

|

이 옵션을 통해 가상 머신의 라이브 마이그레이션 중 마이그레이션 압축을 사용하도록 설정할 수 있습니다. 이 기능은 Xor Binary Zero Run-Length-Encoding을 사용하여 가상 머신 다운 타임 및 집약적 메모리 쓰기 작업을 실행하는 가상 머신이나 스파스 메모리 업데이트 패턴이 있는 애플리케이션의 총 라이브 마이그레이션 시간을 단축할 수 있습니다. 마이그레이션 압축은 전역에서 기본값으로 비활성화되어 있습니다.

|

4.2.2.4. 스케줄링 정책 설정

표 4.7. 스케줄링 정책 탭 속성

|

필드

|

설명/동작

|

|---|---|

|

정책 선택

|

드롭 다운 목록에서 정책을 선택합니다.

|

|

속성

|

다음 속성은 선택한 정책에 따라 표시되며 필요에 따라 수정할 수 있습니다:

|

|

스케줄러 최적화

|

호스트 가중치/순서 스케줄링을 최적화합니다.

|

|

신뢰할 수 있는 서비스 활성화

|

OpenAttestation 서버와의 통합을 활성화합니다. 이를 활성화하기 전

engine-config 도구를 사용하여 OpenAttestation 서버 정보를 입력합니다. 자세한 정보는 9.4절. “신뢰할 수 있는 컴퓨팅 풀”을 참조하십시오.

|

|

HA 예약 활성화

|

Manager를 활성화하여 고가용성 가상 머신 용 클러스터 용량을 모니터링합니다. Manager는 기존 호스트에서 예기치 않은 오류 발생 시 마이그레이션을 위해 고가용성으로 지정된 가상 머신의 클러스터내에 적절한 용량을 보유하도록 합니다.

|

|

사용자 정의 일련 번호 정책 지정

|

이 확인란에서 클러스터에 있는 가상 머신의 일련 번호 정책을 지정합니다. 다음 옵션 중 하나를 선택합니다:

|

|

마이그레이션 자동 컨버전스

|

이 옵션을 통해 클러스터에 있는 가상 머신의 라이브 마이그레이션 중 자동 컨버전스를 사용할 지에 대한 여부를 설정합니다. 워크로드가 큰 대형 가상 머신은 라이브 마이그레이션 중 전송 속도 보다 더 빠르게 더티 메모리 상태가 되어 마이그레이션을 컨버전스하지 못하게 합니다. QEMU의 자동 컨버전스 기능을 통해 가상 머신 마이그레이션 컨버전스를 강제할 수 있습니다. QEMU는 자동으로 컨버전스되지 않음을 감지하고 가상 머신에 있는 vCPU의 스로틀을 감소시킵니다. 자동 컨버전스는 전역에서 기본값으로 비활성화되어 있습니다.

|

|

마이그레이션 압축 활성화

|

이 옵션을 통해 클러스터에 있는 가상 머신의 라이브 마이그레이션 동안 마이그레이션 압축을 사용할 지에 대한 여부를 설정할 수 있습니다. 이 기능은 Xor Binary Zero Run-Length-Encoding을 사용하여 가상 머신 다운 타임 및 집약적 메모리 쓰기 작업을 실행하는 가상 머신이나 메모리 스파스 메모리 업데이트 패턴이 있는 애플리케이션의 총 라이브 마이그레이션 시간을 단축할 수 있습니다. 마이그레이션 압축은 전역에서 기본값으로 비활성화되어 있습니다.

|

mom.Controllers.Balloon - INFO Ballooning guest:half1 from 1096400 to 1991580과 같은 부울 명령이 /var/log/vdsm/mom.log에 기록됩니다. /var/log/vdsm/mom.log는 Memory Overcommit Manager 로그 파일입니다.

4.2.2.5. 클러스터 콘솔 설정

표 4.8. 콘솔 설정

|

필드

|

설명/동작

|

|---|---|

|

클러스터의 SPICE 프록시 정의

|

이 옵션을 선택하여 전체 설정에 지정된 SPICE 프록시 덮어쓰기를 활성화할 수 있습니다. 이 기능은 하이퍼바이저가 있는 네트워크 외부에 사용자 (예를 들어 사용자 포털을 통해 연결된 사용자)가 연결되어 있을 경우에 유용합니다.

|

|

SPICE 프록시 주소 덮어쓰기

|

SPICE 클라이언트는 가상 머신에 연결된 프록시입니다. 주소는 다음과 같은 형식으로 지정해야 합니다:

protocol://[host]:[port] |

4.2.2.6. 펜싱 정책 설정

표 4.9. 펜싱 정책 설정

| 필드 | 설명/동작 |

|---|---|

| 펜싱 활성화 | 클러스터에서 펜싱을 활성화합니다. 펜싱은 기본값으로 활성화되어 있지만 필요에 따라 비활성화할 수 있습니다. 예를 들어 일시적 네트워크 오류가 발생하거나 발생될 것으로 예상되는 경우 관리자는 진단 또는 유지 보수 작업이 완료될 때까지 펜싱을 비활성화할 수 있습니다. 펜싱이 비활성화되어 있을 경우 Non-Responsive 상태에 있는 호스트에서 실행 중인 고가용성 가상 머신은 다른 호스트에서 다시 시작되지 않음에 유의합니다. |

| 호스트가 스토리지에서 유효한 임대를 가지고 있을 경우 펜싱 건너뛰기 | 이 확인란이 선택되어 있을 경우 클러스터에 있는 Non Responsive 상태의 모든 호스트 및 아직 스토리지에 연결되어 있는 호스트는 펜싱되지 않습니다. |

| 클러스터 연결 문제가 있는 경우 펜싱 건너 뛰기 | 이 확인란이 선택되어 있을 경우 클러스터에서 연결 문제가 있는 호스트 비율이 지정된 임계값과 동일하거나 그 이상일 경우 펜싱은 일시적으로 비활성화됩니다. 임계값은 드롭 다운 목록에서 선택하며 사용 가능한 값은 25, 50, 75, 100 입니다. |

4.2.3. 리소스 편집

절차 4.2. 리소스 편집

- 리소스 탭, 트리 모드 또는 검색 기능을 사용하여 검색 결과 목록에서 리소스를 검색 및 선택합니다.

- 을 클릭하여 편집 창을 엽니다.

- 필요한 속성을 변경하고 를 클릭합니다.

4.2.4. 클러스터에 있는 호스트의 전원 관리 정책 및 부하 설정

절차 4.3. 호스트의 전원 관리 정책 및 부하 설정

- 리소스 탭, 트리 모드 또는 검색 기능을 사용하여 검색 결과 목록에서 클러스터를 검색 및 선택합니다.

- 을 클릭하여 클러스터 창을 엽니다.

- 다음 정책 중 하나를 선택합니다:

- none

- vm_evenly_distributed

- 각 호스트에서 실행할 수 있는 최대 가상 머신 수를 HighVmCount 필드에 설정합니다.

- 가장 많이 사용되는 호스트의 가상 머신 수와 가장 적게 사용되는 호스트의 가상 머신 수 사이에서 허용 가능한 최대 차이를MigrationThreshold 필드에 정의합니다.

- SpmVmGrace 필드에 SPM 호스트에 저장된 가상 머신 용 슬롯 수를 지정합니다.

- evenly_distributed

- CpuOverCommitDurationMinutes 필드에서 스테줄링 정책이 작동하기 전 호스트가 지정된 사용량 밖에서 CPU 부하를 실행할 수 있는 시간 (분 단위)을 설정합니다.

- CPU 사용량(백분율)이 얼마가 되면 가상 머신이 다른 호스트로 마이그레이션을 시작하는지 해당 백분율을 HighUtilization 필드에 입력합니다.

- 최소 가용 메모리가 얼마가 되면 가상 머신이 다른 호스트로 마이그레이션을 시작하는지 해당 값을 MB로 MinFreeMemoryForUnderUtilized 필드에 입력합니다.

- 최대 가용 메모리가 얼마가 되면 가상 머신이 다른 호스트로 마이그레이션을 시작하는지 해당 값을 MB로 MaxFreeMemoryForOverUtilized 필드에 입력합니다.

- power_saving

- CpuOverCommitDurationMinutes 필드에서 스테줄링 정책이 작동하기 전 호스트가 지정된 사용량 밖에서 CPU 부하를 실행할 수 있는 시간 (분 단위)을 설정합니다.

- CPU 사용량(백분율)이 얼마 이하로 내려가면 호스트가 충분히 사용되고 있지 않은 것으로 간주되는지 해당 하한값을 백분율로LowUtilization 필드에 입력합니다.

- CPU 사용량(백분율)이 얼마가 되면 가상 머신이 다른 호스트로 마이그레이션을 시작하는지 해당 백분율을 HighUtilization 필드에 입력합니다.

- 최소 가용 메모리가 얼마가 되면 가상 머신이 다른 호스트로 마이그레이션을 시작하는지 해당 값을 MB로 MinFreeMemoryForUnderUtilized 필드에 입력합니다.

- 최대 가용 메모리가 얼마가 되면 가상 머신이 다른 호스트로 마이그레이션을 시작하는지 해당 값을 MB로 MaxFreeMemoryForOverUtilized 필드에 입력합니다.

- 클러스터의 스케줄러 최적화로 다음 중 하나를 선택합니다:

- 사용 최적화를 선택하면 스케줄링에 가중치 모듈을 포함되어 최상의 선택이 가능합니다.

- 속도 최적화를 선택하면 10 개 이상의 대기 중인 요청이 있을 경우 호스트의 가중치를 건너뜁니다.

- OpenAttestation 서버를 사용하여 호스트를 검사하고

engine-config도구를 사용하여 서버 상세 정보를 설정하려면 신뢰할 수 있는 서비스 사용란을 선택합니다. - 옵션으로 HA 예약을 활성화란을 선택하여 Manager가 고가용성 가상 머신 용 클러스터 용량을 모니터할 수 있게 합니다.

- 옵션으로 사용자 정의 일련 번호 정책 지정란을 선택하여 클러스터에 있는 가상 머신의 일련 번호 정책을 지정하고 다음 옵션 중 하나를 선택합니다:

- 가상 머신의 일련 번호로 호스트의 UUID를 설정하기 위해 호스트 ID를 선택합니다.

- 가상 머신의 일련 번호로 가상 머신의 UUID를 설정하기 위해 가상머신 ID를 선택합니다.

- 사용자 정의 일련 번호를 선택하고 텍스트 필드에 사용자 정의 일련 번호를 지정합니다.

- 를 클릭합니다.

4.2.5. 클러스터에 있는 호스트에서 MoM 정책 업데이트

절차 4.4. 호스트에서 MoM 정책 동기화

- 클러스터 탭을 클릭하고 호스트가 속해 있는 클러스터를 선택합니다.

- 상세 정보 창에서 호스트 탭을 클릭하고 MoM 정책을 업데이트해야 하는 호스트를 선택합니다.

- 버튼을 클릭합니다.

4.2.6. CPU 프로파일

4.2.6.1. CPU 프로파일 생성

절차 4.5. CPU 프로파일 생성

- 클러스터 리소스 탭을 클릭하고 클러스터를 선택합니다.

- 상세 정보 창에서 CPU 프로파일 하위 탭을 클릭합니다.

- 를 클릭합니다.

- 이름 란에 CPU 프로파일 이름을 입력합니다.

- 설명 란에 CPU 프로파일 설명을 입력합니다.

- QoS 목록에서 CPU 프로파일에 적용할 QoS를 선택합니다.

- 를 클릭합니다.

4.2.6.2. CPU 프로파일 삭제

절차 4.6. CPU 프로파일 삭제

- 클러스터 리소스 탭을 클릭하고 클러스터를 선택합니다.

- 상세 정보 창에서 CPU 프로파일 하위 탭을 클릭합니다.

- 삭제하고자 하는 CPU 프로파일을 선택합니다.

- 를 클릭합니다.

- 를 클릭합니다.

default CPU 프로파일이 지정됩니다.

4.2.7. 기존의 Red Hat Gluster Storage 클러스터 가져오기

gluster peer status 명령을 호스트에서 실행하면 클러스터의 일부인 호스트 목록이 표시됩니다. 수동으로 각 호스트의 지문을 확인하고 암호를 제공해야 합니다. 클러스터에 있는 호스트 중 하나가 중지되어 있거나 연결할 수 없는 경우 클러스터를 가져올 수 없습니다. 새로 가져온 호스트에는 VDSM이 설치되어 있지 않지만 가져오기한 후 부트스트랩 스크립트는 호스트에 필요한 모든 VDSM 패키지를 설치한 후 이를 재부팅합니다.

절차 4.7. 기존 Red Hat Gluster Storage Cluster를 Red Hat Virtualization Manager에 가져오기

- 클러스터 리소스 탭을 선택하여 결과 목록에 모든 클러스터를 나열합니다.

- 버튼을 클릭하여 새 클러스터 창을 엽니다.

- 드롭 다운 메뉴에서 클러스터가 속한 데이터 센터를 선택합니다.

- 클러스터의 이름 및 설명을 입력합니다.

- 클러스터 서비스 활성화 라디오 버튼 및 기존 클러스터 설정 가져오기 체크 상자를 선택합니다.기존 Gluster 설정 가져오기 필드는 Gluster 서비스 활성화 라디오 버튼을 선택한 경우에만 표시됩니다.

- 주소 필드에 클러스터에 있는 서버의 IP 주소 또는 호스트 이름을 입력합니다.호스트 지문이 표시되어 올바른 호스트와 연결되어 있는지 확인합니다. 호스트가 도달할 수 없거나 네트워크 오류가 있을 경우 지문 검색 중 오류 발생 메세지가 지문 필드에 표시됩니다.

- 서버의 Root 암호를 입력하고 OK를 클릭합니다.

- 호스트 추가 창이 열리면 클러스터의 일부분인 호스트 목록이 표시됩니다.

- 각 호스트에 대해 이름 및 Root 암호를 입력합니다.

- 모든 호스트에 대해 동일한 암호를 사용하고자 할 경우 일반 암호 사용 확인란을 선택하여 지정된 텍스트 필드에 암호를 입력합니다.버튼을 클릭하여 입력된 암호를 모든 호스트에 설정합니다.를 클릭하여 지문이 유효한지 확인하고 변경 사항을 제출합니다.

4.2.8. 호스트 추가 창 설정

표 4.10. Gluster 호스트 설정 추가

| 필드 | 설명 |

|---|---|

| 공통 암호 사용 | 클러스터에 속한 모든 호스트에 대해 동일한 암호를 사용하려면 이 체크 박스를 선택합니다. 암호란에 암호를 입력한 후 적용 버튼을 클릭하면 모든 호스트에 암호가 설정됩니다. |

| 성명 | 호스트 이름을 입력합니다. |

| 호스트 이름/IP | 이 필드는 새 클러스터 창에 지정한 호스트의 정규화된 도메인 이름 또는 IP로 자동 입력됩니다. |

| Root 암호 | 각 호스트에 다른 root 암호를 사용하려면 이 필드에 암호를 입력합니다. 이 필드는 클러스터에 있는 모든 호스트에 지정된 공통 암호를 덮어쓰기합니다. |

| 지문 | 올바른 호스트와 연결되어 있는지 확인하기 위해 호스트 지문이 표시됩니다. 이 필드는 새 클러스터 창에 지정된 호스트의 지문으로 자동 입력됩니다. |

4.2.9. 클러스터 삭제

참고

절차 4.8. 클러스터 삭제

- 리소스 탭, 트리 모드 또는 검색 기능을 사용하여 검색 결과 목록에서 클러스터를 검색 및 선택합니다.

- 클러스터에 호스트가 없는지 확인합니다.

- 를 클릭하면 클러스터 삭제 확인 창이 열립니다.

- 를 클릭합니다.

4.2.10. 클러스터 호환 버전 변경

참고

절차 4.9. 클러스터 호환 버전 변경

- 관리 포털에서 클러스터 탭을 클릭합니다.

- 목록에서 변경할 클러스터를 선택합니다.

- 을 클릭합니다.

- 호환 버전을 원하는 값으로 변경합니다.

- 를 클릭하여 클러스터 호환 버전 변경 확인 창을 엽니다.

- 를 클릭하여 확인합니다.

중요

4.3. 클러스터 및 권한

4.3.1. 클러스터의 시스템 권한 관리

- 관련된 클러스터를 생성 및 삭제합니다.

- 클러스터와 관련된 호스트, 가상 머신, 풀을 추가 및 삭제합니다.

- 클러스터와 관련된 가상 머신의 사용자 권한을 편집합니다.

참고

4.3.2. 클러스터 관리자 역할

표 4.11. Red Hat Virtualization 시스템 관리자 역할

| 역할 | 권한 | 알림 |

|---|---|---|

| ClusterAdmin | 클러스터 관리자 |

호스트 , 템플릿, 가상 머신을 포함하여 특정 클러스터에 있는 모든 물리 및 가상 리소스를 사용, 생성, 삭제, 관리할 수 있습니다. 디스플레이 네트워크를 지정하거나 필요 또는 불필요에 따라 네트워크를 표시하는 등 클러스터 내의 네트워크 속성을 설정할 수 있습니다.

하지만 ClusterAdmin은 클러스터에서 네트워크를 연결 또는 분리할 수 있는 권한이 없습니다. 이러한 작업을 실행하려면 NetworkAdmin 권한이 있어야 합니다.

|

| NetworkAdmin | 네트워크 관리자 | 특정 클러스터의 네트워크를 설정 및 관리할 수 있습니다. 클러스터의 네트워크 관리자는 클러스터 내의 가상 머신에 대한 네트워크 권한을 상속합니다. |

4.3.3. 리소스에 관리자 또는 사용자 역할 할당

절차 4.10. 리소스에 역할 할당

- 리소스 탭, 트리 모드 또는 검색 기능을 사용하여 검색 결과 목록에서 리소스를 검색 및 선택합니다.

- 상세 정보 창에 있는 탭을 클릭하여 할당된 사용자, 사용자 역할, 선택한 리소스에 대해 상속된 권한을 나열합니다.

- 를 클릭합니다.

- 검색 텍스트 상자에 기존 사용자의 이름 또는 사용자 이름을 입력하고 을 클릭합니다. 검색 결과 목록에서 일치하는 사용자를 선택합니다.

- 할당된 역할: 드롭 다운 목록에서 역할을 선택합니다.

- 를 클릭합니다.

4.3.4. 리소스에서 관리자 또는 사용자 역할 삭제

절차 4.11. 리소스에서 역할 삭제

- 리소스 탭, 트리 모드 또는 검색 기능을 사용하여 검색 결과 목록에서 리소스를 검색 및 선택합니다.

- 상세 정보 창에 있는 탭을 클릭하여 할당된 사용자 목록, 사용자 역할, 선택한 리소스에서 상속된 권한을 나열합니다.

- 리소스에서 삭제할 사용자를 선택합니다.

- 를 클릭합니다. 권한 삭제 창이 열리면 권한 삭제를 확인합니다.

- 를 클릭합니다.

5장. 논리 네트워크

5.1. 논리 네트워크 작업

5.1.1. 네트워크 탭 사용

- 클러스터 및 호스트에 네트워크를 연결 또는 분리

- 가상 머신 및 템플릿에서 네트워크 인터페이스 삭제

- 네트워크 액세스 및 관리를 위해 사용자 권한 추가 및 삭제

주의

중요

- 디렉토리 서비스

- DNS

- 스토리지

5.1.2. 데이터 센터 또는 클러스터에 새 논리 네트워크 생성

절차 5.1. 데이터 센터 또는 클러스터에 새 논리 네트워크 생성

- 데이터 센터 또는 클러스터 리소스 탭을 클릭하고 검색 결과 목록에서 데이터 센터 또는 클러스터를 선택합니다.

- 상세 정보 창의 논리 네트워크 탭을 클릭하여 기존 논리 네트워크를 나열합니다.

- 데이터 센터 상세 정보 창에서 버튼을 클릭하여 새 논리 네트워크 창을 엽니다.

- 클러스터 상세 정보 창에서 를 클릭하여 새 논리 네트워크 창을 엽니다.

- 논리 네트워크의 이름, 설명, 코멘트를 입력합니다.

- 옵션으로 외부 공급자에 생성 확인란을 선택합니다. 드롭 다운 목록에서 외부 공급자를 선택하고 물리 네트워크의 IP 주소를 지정합니다. 외부 공급자 드롭 다운 목록에는 읽기 전용 모드의 외부 공급자가 표시되지 않습니다.외부 공급자에 생성이 선택되어 있을 경우 네트워크 레이블, 가상 머신 네트워크, MTU 옵션은 비활성화됩니다.

- 네트워크 레이블 텍스트 필드에서 논리 네트워크에 새로운 레이블을 입력하거나 기존 레이블을 선택합니다.

- 옵션으로 VLAN 태그 활성화를 활성화합니다.

- 옵션으로 가상 머신 네트워크를 비활성화합니다.

- MTU 값을 기본 (1500) 또는 사용자 정의로 설정합니다.

- 클러스터 탭에서 네트워크를 지정할 클러스터를 선택합니다. 논리 네트워크를 필수 네트워크로 할 지에 대한 여부를 지정할 수 있습니다.

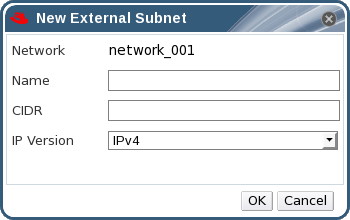

- 외부 공급자에 생성을 선택한 경우 서브넷 탭이 표시됩니다. 서브넷 탭에서 서브넷 생성을 선택하고 논리 네트워크가 제공하는 서브넷의 이름, CIDR, 게이트웨이 주소를 입력하고 IP 버전을 선택합니다. 필요에 따라 DNS 서버를 추가할 수 있습니다.

- vNIC 프로파일 탭에서 필요에 따라 논리 네트워크에 vNIC 프로파일을 추가합니다.

- OK를 클릭합니다.

참고

5.1.3. 논리 네트워크 편집

절차 5.2. 논리 네트워크 편집

중요

- 데이터 센터 리소스 탭을 클릭하고 검색 결과 목록에서 논리 네트워크의 데이터 센터를 선택합니다.

- 상세 정보 창에서 논리 네트워크 탭을 클릭하여 데이터 센터에 논리 네트워크 목록을 나열합니다.

- 논리 네트워크를 선택하고 을 클릭하여 논리 네트워크 편집 창을 엽니다.

- 필요한 설정을 편집합니다.

- OK를 클릭하여 변경 사항을 저장합니다.

참고

5.1.4. 논리 네트워크 삭제

ovirtmgmt 관리 네트워크로 사용되는 최소 하나의 논리 네트워크가 있어야 합니다.

절차 5.3. 논리 네트워크 삭제

- 데이터 센터 리소스 탭을 클릭하고 검색 결과 목록에서 논리 네트워크의 데이터 센터를 선택합니다.

- 상세 정보 창에서 논리 네트워크 탭을 클릭하여 데이터 센터에 논리 네트워크 목록을 나열합니다.

- 논리 네트워크를 선택하고 버튼을 클릭하여 논리 네트워크 삭제 창을 엽니다.

- 네트워크가 외부 공급자에 의해 제공되는 경우 옵션으로 공급자에서 외부 네트워크 삭제 확인란을 선택하여 Manager 및 외부 공급자 모두에서 논리 네트워크를 삭제합니다. 외부 공급자가 읽기 전용 모드인 경우 확인란이 회색으로 표시되어 사용할 수 없습니다.

- OK를 클릭합니다.

5.1.5. 논리 네트워크의 게이트웨이 표시 또는 편집

절차 5.4. 논리 네트워크의 게이트웨이 표시 또는 편집

- 호스트 리소스 탭을 클릭하여 원하는 호스트를 선택합니다.

- 상세 정보 창에서 네트워크 인터페이스 탭을 클릭하여 호스트 및 호스트 설정에 연결된 네트워크 인터페이스를 나열합니다.

- 버튼을 클릭하여 호스트 네트워크 설정 창을 엽니다.

- 할당된 논리 네트워크 위에 커서를 이동하고 연필 모양의 아이콘을 클릭하여 관리 네트워크 편집 창을 엽니다.

5.1.6. 새 논리 네트워크 및 논리 네트워크 편집 창 설정 및 제어

5.1.6.1. 논리 네트워크의 일반 설정에 대한 설명

표 5.1. 새 논리 네트워크 및 논리 네트워크 편집

|

필드 이름

|

설명

|

|---|---|

|

이름

|

논리 네트워크의 이름입니다. 텍스트 필드는 최대 15자로 제한되어 있으며 알파벳 대문자, 소문자, 숫자, 하이픈, 밑줄로 조합된 고유한 이름이어야 합니다.

|

|

설명

|

논리 네트워크의 설명입니다. 이 텍스트 필드는 최대 40 자로 제한되어 있습니다.

|

|

코멘트

|

논리 네트워크 관련 일반 텍스트 형식의 사용자가 읽을 수 있는 코멘트를 추가하기 위한 필드입니다.

|

|

외부 공급자에 생성

|

외부 공급자로 Manager에 추가된 OpenStack Networking 인스턴스에 논리적 네트워크를 생성할 수 있습니다.

외부 공급자 - 논리 볼륨이 생성될 외부 공급자를 선택할 수 있습니다.

|

|

VLAN 태그 활성화

|

VLAN 태그는 논리 네트워크에서 모든 네트워크 트래픽에 특정 특성을 지정하는 보안 기능입니다. VLAN 태그가 붙은 트래픽은 동일한 특성을 가는 인터페이스에서 읽을 수 없습니다. 논리 네트워크에서 VLAN 을 사용하면 하나의 네트워크 인터페이스를 VLAN 태그가 붙은 여러 다른 논리 네트워크에 연결할 수 있습니다. VLAN 태그를 사용하려면 텍스트 입력 필드에 숫자를 입력합니다.

|

|

가상 머신 네트워크

|

가상 머신만 네트워크를 사용하는 경우 이 옵션을 선택합니다. 네트워크가 가상 머신에 관련 없이 스토리지 용 통신과 같은 트래픽에 사용되는 경우 이를 선택하지 마십시오.

|

|

MTU

|

기본을 선택하여 논리 네트워크의 최대 전송 단위 (MTU: Maximum Transmission Unit)를 괄호 안의 값으로 설정하거나 사용자 지정을 선택하여 사용자 지정 MTU를 설정합니다. 이를 사용하여 새 논리 네트워크가 지원하는 MTU 값과 인터페이스 연결하는 하드웨어가 지원하는 MTU 값을 적용할 수 있습니다. 사용자 지정을 선택한 경우 텍스트 입력 필드에 숫자를 입력합니다.

|

|

네트워크 레이블

|

네트워크의 새 레이블을 지정하거나 호스트 네트워크 인터페이스에 이미 연결된 기존 레이블에서 선택하여 지정할 수 있습니다. 기존 레이블을 선택한 경우 논리 네트워크는 레이블된 전체 호스트 네트워크 인터페이스에 자동으로 할당됩니다.

|

5.1.6.2. 논리 네트워크 클러스터 설정

표 5.2. 새 논리 네트워크 설정

|

필드 이름

|

설명

|

|---|---|

|

클러스터에서 네트워크를 연결/분리

|

데이터 센터에 있는 클러스터에서 논리 네트워크를 연결 또는 분리할 수 있으며 개별 클러스터의 네트워크에 논리 네트워크가 필요한지에 대한 여부를 지정할 수 있습니다.

이름 - 설정을 적용할 클러스터 이름입니다. 이 값은 편집할 수 없습니다.

모두 연결 - 데이터 센터에 있는 모든 클러스터에서 논리 네트워크를 연결 또는 분리할 수 있습니다. 다른 방법으로 각각의 클러스터 이름 옆에 있는 연결 확인란을 선택 또는 선택 해제하여 지정된 클러스터에서 논리 네트워크를 연결 또는 분리할 수 있습니다.

모두 필수 - 모든 클러스터에서 논리 네트워크가 필수 네트워크인지의 여부를 지정할 수 있습니다. 다른 방법으로 각각의 클러스터 이름 옆에 있는 필수 확인란을 선택 또는 선택 해제하여 지정된 클러스터에서 논리 네트워크가 필수 항목인지의 여부를 지정할 수 있습니다.

|

5.1.6.3. 논리 네트워크의 vNIC 프로파일 설정

표 5.3. 새 논리 네트워크 설정

|

필드 이름

|

설명

|

|---|---|

|

vNIC 프로파일

|

논리 네트워크에 하나 이상의 vNIC 프로파일을 지정할 수 있습니다. vNIC 프로파일 옆의 플러스 또는 마이너스 버튼을 클릭하여 논리 네트워크에 vNIC 프로파일을 추가하거나 삭제할 수 있습니다.

공개 - 프로파일을 모든 사용자가 사용할 수 있는지에 대한 여부를 지정할 수 있습니다.

QoS - vNIC 프로파일에 네트워크 QoS (quality of service) 프로파일을 지정할 수 있습니다.

|

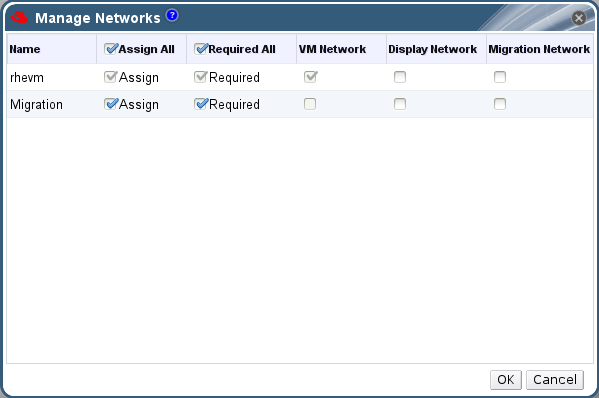

5.1.7. 네트워크 관리 창에서 논리 네트워크에 특정 트래픽 유형을 지정

절차 5.5. 논리 네트워크의 트래픽 유형 지정

- 클러스터 리소스 탭을 클릭하고 결과 목록에서 클러스터를 선택합니다.

- 상세 정보 창에서 논리 네트워크 탭을 선택하여 클러스터에 할당된 논리 네트워크를 나열합니다.

- 를 클릭하여 네트워크 관리 창을 엽니다.

- 해당 확인란을 선택합니다.

- 를 클릭하여 변경 사항을 저장하고 창을 닫습니다.

참고

5.1.8. 네트워크 관리 창 설정

표 5.4. 네트워크 관리 설정

|

필드

|

설명/동작

|

|---|---|

|

할당

|

클러스터에 있는 모든 호스트에 논리 네트워크를 할당합니다.

|

|

필수

|

네트워크에 연결된 호스트가 제대로 작동하려면 "필수"로 표시된 네트워크를 작동하는 상태로 두어야 합니다. 필수 네트워크가 작동을 중단하는 경우 네트워크에 연결된 모든 호스트는 비 작동 상태가 됩니다.

|

|

가상 머신 네트워크

| "가상 머신 네트워크"로 표시된 논리 네트워크는 가상 머신 네트워크와 관련된 네트워크 트래픽을 전송합니다. |

|

디스플레이 네트워크

| "디스플레이 네트워크"로 표시된 논리 네트워크는 SPICE 및 가상 네트워크 컨트롤러와 관련된 네트워크 트래픽을 전송합니다. |

|

마이그레이션 네트워크

| "마이그레이션 네트워크"로 표시된 논리 네트워크는 가상 머신 및 스토리지 마이그레이션 트래픽을 전송합니다. |

5.1.9. NIC에서 VF (Virtual Function) 설정 편집

절차 5.6. NIC에서 VF (Virtual Function) 설정 편집

- SR-IOV가 가능한 호스트를 선택하고 상세 정보 창에서 네트워크 인터페이스 탭을 클릭합니다.

- 을 클릭하여 호스트 네트워크 설정 창을 엽니다.

로 표시된 SR-IOV가 가능한 NIC를 선택하고 연필 모양의 아이콘을 클릭하여 NICVF (SR-IOV) 설정 편집 창을 엽니다.

로 표시된 SR-IOV가 가능한 NIC를 선택하고 연필 모양의 아이콘을 클릭하여 NICVF (SR-IOV) 설정 편집 창을 엽니다.

- VF 설정 수 드롭 다운 버튼을 클릭하고 VF 수 필드를 수정해서 VF의 수를 편집합니다.

중요

VF 수량 변경 시 네트워크에 있는 기존 VF가 모두 삭제된 후 새 VF가 생성됩니다. 여기에는 가상 머신이 직접 연결된 VF도 모두 포함됩니다. - 전체 네트워크 체크 상자가 기본으로 선택되어 모든 네트워크에서 VF에 액세스할 수 있습니다. VF 액세스가 허용된 가상 네트워크를 지정하려면 특정 네트워크 라디오 버튼을 선택해서 모든 네트워크를 나열합니다. 원하는 네트워크의 체크 상자를 선택하거나 레이블 텍스트 영역을 사용해서 하나 이상의 네트워크 레이블을 바탕으로 자동으로 네트워크를 선택합니다.

- 버튼을 클릭하여 창을 닫습니다. 호스트 네트워크 설정 창의 버튼을 클릭해야 변경 사항이 저장됩니다.

5.2. 가상 네트워크 인터페이스 카드

5.2.1. vNIC 프로파일 개요

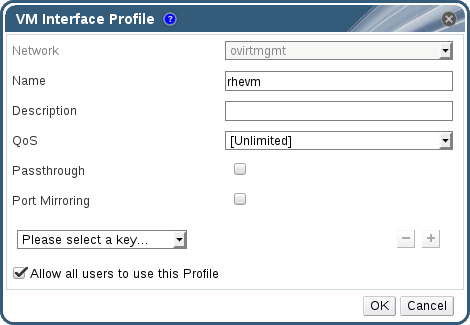

5.2.2. vNIC 프로파일 생성 또는 편집

참고

절차 5.7. vNIC 프로파일 생성 또는 편집

- 네트워크 리소스 탭을 클릭하여 결과 창에 있는 논리 네트워크를 선택합니다.

- 상세 정보 창에서 vNIC 프로파일 탭을 선택합니다. 트리 모드에서 논리 네트워크를 선택한 경우 결과 목록에서 vNIC 프로파일 탭을 선택할 수 있습니다.

- 또는 을 클릭하여 가상 머신 인터페이스 프로파일 창을 엽니다.

- 프로파일의 이름 및 설명을 입력합니다.

- QoS 목록에서 적절한 QoS 정책을 선택합니다.

- 통과 체크 상자를 선택하여 vNIC 통과(passthrough)를 활성화하고 VF의 직접 장치 할당을 허용합니다. 통과 속성을 활성화 시 이와 호환되지 않는 QoS 및 포트 미러링이 비활성화됩니다. 통과에 대한 자세한 내용은 5.2.4절. “vNIC 프로파일 통과(passthrough) 활성화”를 참조하십시오.

- 포트 미러링 및 모든 사용자가 이 프로파일을 사용하도록 허용 확인란에서 이러한 옵션을 변환합니다.

- 기본값으로 키를 선택하십시오...가 표시되는 사용자 정의 속성 목록에서 사용자 정의 속성을 선택합니다. 및 버튼을 사용하여 사용자 정의 속성을 추가 또는 삭제합니다.

- 를 클릭합니다.

참고

5.2.3. 가상 머신 인터페이스 프로파일 창 설정

표 5.5. 가상 머신 인터페이스 프로파일 창

|

필드 이름

|

설명

|

|---|---|

|

네트워크

|

vNIC 프로파일을 적용하기 위한 사용 가능한 네트워크의 드롭 다운 메뉴입니다.

|

|

이름

|

vNIC 프로파일 이름입니다. 1에서 50 자 사이의 알파벳 대소문자, 숫자, 하이픈, 밑줄로 조합된 고유한 이름이어야 합니다.

|

| 설명 |

vNIC 프로파일 설명입니다. 이는 권장 사항이며 필수 입력 사항은 아닙니다.

|

| QoS |

vNIC 프로파일에 적용할 사용 가능한 네트워크 QoS (Quality of Service) 정책의 드롭 다운 메뉴입니다. QoS 정책은 vNIC의 인바운드 및 아웃바운드 네트워크 트래픽을 조절합니다.

|

| Passthrough |

통과(passthrough) 속성을 토글하는 체크 상자입니다. 통과는 vNIC가 호스트 NIC의 가상 기능에 직접 연결이 가능하게 합니다. vNIC 프로파일이 가상 머신에 연결되어 있는 경우 통과 속성이 편집될 수 없습니다.

통과 활성화 시 vNIC 프로파일에 QoS 및 포트 미러링이 비활성화됩니다.

|

| 포트 미러링 |

포트 미러링을 전환하기 위한 확인란입니다. 포트 미러링은 논리 네트워크에 있는 레이어 3 네트워크 트래픽을 가상 머신 상의 가상 인터페이스에 복사합니다. 이는 기본값으로 선택 설정되어 있지 않습니다. 보다 자세한 내용은 Technical Reference에 있는 Port Mirroring에서 확인하십시오.

|

| 장치 사용자 정의 속성 |

vNIC 프로파일에 적용할 사용 가능한 사용자 정의 속성을 선택하기 위한 드롭 다운 메뉴입니다. 및 버튼을 사용하여 속성을 추가 또는 삭제합니다.

|

| 모든 사용자가 이 프로파일을 사용하도록 허용 |

환경에 있는 모든 사용자에게 프로파일의 사용 가능 여부를 전환하기 위한 확인란입니다. 이는 기본값으로 선택 설정되어 있습니다.

|

5.2.4. vNIC 프로파일 통과(passthrough) 활성화

절차 5.8. 통과 활성화

- 네트워크 결과 목록에서 논리 네트워크 선택 후 상세 정보 창에서 vNIC 프로파일 탭을 클릭해서 해당 논리 네트워크의 모든 vNIC 프로파일을 나열합니다.

- 를 클릭하여 가상 머신 인터페이스 프로파일 창을 엽니다.

- 프로파일의 이름 및 설명을 입력합니다.

- 통과 체크 상자를 선택합니다. QoS 및 포트 미러링이 비활성화됩니다.

- 필요한 경우 기본값으로 키를 선택하십시오...가 표시되는 사용자 정의 속성 목록에서 사용자 정의 속성을 선택합니다. 및 버튼을 사용하여 사용자 정의 속성을 추가 또는 삭제합니다.

- 를 클릭하여 프로파일을 저장하고 창을 닫습니다.

5.2.5. vNIC 프로파일 삭제

절차 5.9. vNIC 프로파일 삭제

- 네트워크 리소스 탭을 클릭하여 결과 창에 있는 논리 네트워크를 선택합니다.

- 상세 정보 창에서 프로파일 탭을 선택하여 사용 가능한 vNIC 프로파일을 표시합니다. 트리 모드에서 논리 네트워크를 선택한 경우 결과 목록에서 VNIC 프로파일 탭을 선택할 수 있습니다.

- 하나 이상의 프로파일을 선택하고 를 클릭하여 가상 머신 인터페이스 프로파일 삭제 창을 엽니다.

- 를 클릭하여 프로파일을 삭제하고 창을 닫습니다.

5.2.6. vNIC 프로파일에 보안 그룹 할당

참고

참고

# neutron security-group-list

절차 5.10. vNIC 프로파일에 보안 그룹 할당

- 네트워크 탭을 클릭하여 결과 창에 있는 논리 네트워크를 선택합니다.

- 상세 정보 창에서 vNIC 프로파일 탭을 클릭합니다.

- 를 클릭하거나 또는 기존 vNIC 프로파일을 선택하고 을 클릭하여 가상 머신 인터페이스 프로파일 창을 엽니다.

- 사용자 정의 속성 드롭 다운 목록에서 보안 그룹을 선택합니다. 사용자 정의 속성 드롭 다운 목록이 비워 있을 경우 기본 보안 그룹이 적용되어 모든 아웃바운드 트래픽 및 내부 통신을 허용하지만 기본 보안 그룹 외부에서 들어오는 모든 인바운드 트래픽은 거부합니다. 보안 그룹 속성을 나중에 삭제해도 이미 적용된 보안 그룹에는 영향을 주지 않음에 유의합니다.

- 텍스트 필드에 vNIC 프로파일에 연결할 보안 그룹 ID를 입력합니다.

- 를 클릭합니다.

5.2.7. vNIC 프로파일 사용자 권한

절차 5.11. vNIC 프로파일 사용자 권한

- 네트워크 탭을 클릭하여 결과 창에 있는 논리 네트워크를 선택합니다.

- vNIC 프로파일 리소스 탭을 선택하여 vNIC 프로파일을 표시합니다.

- 상세 정보 창에서 권한 탭을 선택하여 프로파일의 현재 사용자 권한을 표시합니다.

- 버튼을 사용하여 사용자에게 권한 추가 창을 열고 버튼을 사용하여 권한 삭제 창을 열어 vNIC 프로파일의 사용자 권한을 설정합니다.

5.2.8. UCS 통합을 위한 vNIC 프로파일 설정

vdsm-hook-vmfex-dev 후크를 사용하여 가상 머신이 vNIC 설정 후 Cisco의 UCS 정의 포트 프로파일에 연결될 수 있습니다. UCS 정의 포트 프로파일에는 UCS의 가상 인터페이스 설정에 사용되는 속성과 설정이 포함되어 있습니다. 기본값으로 vdsm-hook-vmfex-dev 후크가 VDSM에 설치됩니다. 더 자세한 정보는 부록 A. VDSM 및 후크를 참조하십시오.

참고

절차 5.12. 사용자 정의 장치 속성 설정

- Red Hat Virtualization Manager에서

--cver을 사용해서vmfex사용자 정의 속성 및 클러스터 호환 수준을 설정합니다.# engine-config -s CustomDeviceProperties='{type=interface;prop={vmfex=^[a-zA-Z0-9_.-]{2,32}$}}' --cver=3.6 vmfex사용자 정의 장치 속성의 추가 여부를 확인합니다.# engine-config -g CustomDeviceProperties

- engine을 다시 시작합니다.

# service ovirt-engine restart

절차 5.13. UCS 통합을 위한 vNIC 프로파일 설정

- 네트워크 리소스 탭을 클릭하여 결과 창에 있는 논리 네트워크를 선택합니다.

- 상세 정보 창에서 vNIC 프로파일 탭을 선택합니다. 트리 모드에서 논리 네트워크를 선택한 경우 결과 목록에서 vNIC 프로파일 탭을 선택할 수 있습니다.

- 또는 을 클릭하여 가상 머신 인터페이스 프로파일 창을 엽니다.

- 프로파일의 이름 및 설명을 입력합니다.

- 사용자 정의 속성 목록에서

vmfex사용자 정의 속성을 선택하고 UCS 포트 프로파일 이름을 입력합니다. - 를 클릭합니다.

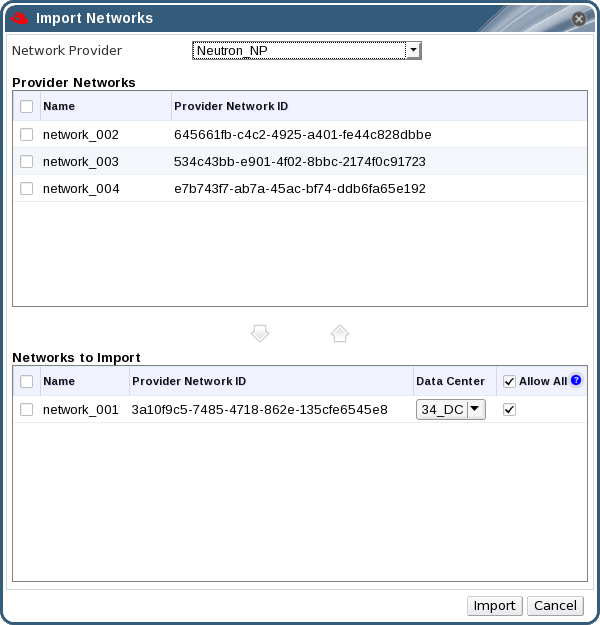

5.3. 외부 공급자 네트워크

5.3.1. 외부 공급자에서 네트워크 가져오기

절차 5.14. 외부 공급자에서 네트워크 가져오기

- 네트워크 탭을 클릭합니다.

- 버튼을 클릭하여 네트워크 가져오기 창을 엽니다.

- 네트워크 공급자 드롭 다운 메뉴에서 외부 공급자를 선택합니다. 공급자가 제공하는 네트워크가 자동으로 감지되어 공급자 네트워크 목록에 나열됩니다.

- 체크 상자를 사용하여 공급자 네트워크 목록에서 가져오기할 네트워크를 선택하고 아래로 이동 화살표를 클릭하여 이 네트워크를 가져오기할 네트워크 목록으로 이동합니다.

- 가져오기 할 네트워크 이름을 사용자가 지정할 수 있습니다. 이름을 사용자 지정하려면 이름 란에 있는 네트워크 이름을 클릭하고 텍스트를 변경합니다.

- 데이터 센터 드롭 다운 목록에서 네트워크를 가져오기할 데이터 센터를 선택합니다.

- 옵션으로 가져오기할 네트워크 목록에 있는 네트워크의 모두 허용 체크 상자를 선택해제하여 모든 사용자에게 네트워크 사용을 허용하지 않습니다.

- 버튼을 클릭합니다.

5.3.2. 외부 공급자 네트워크 사용 제한

- 외부 공급자가 제공하는 논리 네트워크는 가상 머신 네트워크로 사용해야 하며 디스플레이 네트워크로 사용할 수 없습니다.

- 동일한 논리 네트워크를 다른 데이터 센터에만 한 번 이상 가져오기할 수 있습니다.

- Manager에서 외부 공급자가 제공하는 논리 네트워크를 편집할 수 없습니다. 외부 공급자가 제공하는 논리 네트워크의 상세 정보를 편집하려면 논리 네트워크를 제공하는 외부 공급자에서 논리 네트워크를 직접 편집해야 합니다.

- 외부 공급자에서 제공하는 논리 네트워크에 연결된 가상 네트워크 인터페이스 카드의 경우 포트 미러링을 사용할 수 없습니다.

- 외부 공급자가 제공하는 논리 네트워크를 가상 머신이 사용할 경우 논리 네트워크가 가상 머신에 의해 사용되고 있는 동안 Manager에서 공급자를 삭제할 수 없습니다.

- 외부 공급자가 제공하는 네트워크는 필수가 아닙니다. 따라서 이러한 논리 네트워크를 가져오기한 클러스터 스케줄링 시 호스트 선택에서 이러한 논리 네트워크를 고려하지 않습니다. 이에 더하여 사용자는 이러한 논리 네트워크를 가져오기한 클러스터에 있는 호스트 상의 논리 네트워크를 사용할 수 있게 해야 합니다.

중요

5.3.3. 외부 공급자 논리 네트워크에서 서브넷 설정

5.3.3.1. 외부 공급자 논리 네트워크에서 서브넷 설정

5.3.3.2. 외부 공급자 논리 네트워크에 서브넷 추가

5.4. 논리 네트워크 및 권한

5.4.1. 네트워크의 시스템 권한 관리

- 네트워크를 생성, 편집, 삭제합니다.

- 포트 미러링 설정을 포함하여 네트워크 설정을 편집합니다.

- 클러스터 및 가상 머신을 포함하여 리소스에서 네트워크를 연결 및 분리합니다.

5.4.2. 네트워크 관리자 및 사용자 역할

표 5.6. Red Hat Virtualization 네트워크 관리자 및 사용자 역할

| 역할 | 권한 | 알림 |

|---|---|---|

| NetworkAdmin | 데이터 센터, 클러스터, 호스트, 가상 머신, 템플릿에 대한 네트워크 관리자입니다. 네트워크를 생성한 사용자에게는 생성된 네트워크에 대한 NetworkAdmin 권한이 자동으로 부여됩니다. | 특정 데이터 센터, 클러스터, 호스트, 가상 머신, 템플릿의 네트워크를 설정 및 관리할 수 있습니다. 데이터 센터 또는 클러스터의 네트워크 관리자는 클러스터 내의 가상 풀에 대한 네트워크 권한을 상속합니다. 가상 머신 네트워크에서 포트 미러링을 설정하려면 네크워크에서 NetworkAdmin 역할 및 가상 머신에서 UserVmManager 역할을 적용합니다. |

| VnicProfileUser | 가상 머신 및 템플릿에 대한 논리 네트워크 및 네트워크 인터페이스 사용자입니다. | 특정 논리 네트워크에서 네트워크 인터페이스를 연결 또는 분리할 수 있습니다. |

5.4.3. 리소스에 관리자 또는 사용자 역할 할당

절차 5.17. 리소스에 역할 할당

- 리소스 탭, 트리 모드 또는 검색 기능을 사용하여 검색 결과 목록에서 리소스를 검색 및 선택합니다.

- 상세 정보 창에 있는 탭을 클릭하여 할당된 사용자, 사용자 역할, 선택한 리소스에 대해 상속된 권한을 나열합니다.

- 를 클릭합니다.

- 검색 텍스트 상자에 기존 사용자의 이름 또는 사용자 이름을 입력하고 을 클릭합니다. 검색 결과 목록에서 일치하는 사용자를 선택합니다.

- 할당된 역할: 드롭 다운 목록에서 역할을 선택합니다.

- 를 클릭합니다.

5.4.4. 리소스에서 관리자 또는 사용자 역할 삭제

절차 5.18. 리소스에서 역할 삭제

- 리소스 탭, 트리 모드 또는 검색 기능을 사용하여 검색 결과 목록에서 리소스를 검색 및 선택합니다.

- 상세 정보 창에 있는 탭을 클릭하여 할당된 사용자 목록, 사용자 역할, 선택한 리소스에서 상속된 권한을 나열합니다.

- 리소스에서 삭제할 사용자를 선택합니다.

- 를 클릭합니다. 권한 삭제 창이 열리면 권한 삭제를 확인합니다.

- 를 클릭합니다.

5.5. 호스트 및 네트워킹

5.5.1. 호스트 기능 새로 고침

절차 5.19. 호스트 기능 새로 고침 방법

- 리소스 탭, 트리 모드 도는 검색 기능을 사용하여 검색 결과 목록에서 호스트를 검색 및 선택합니다.

- 기능을 새로 고침 버튼을 클릭합니다.

5.5.2. 호스트 네트워크 인터페이스 편집 및 호스트에 논리 네트워크 할당

중요

절차 5.20. 호스트 네트워크 인터페이스 편집 및 호스트에 논리 네트워크 할당

- 호스트 리소스 탭을 클릭하여 원하는 호스트를 선택합니다.

- 상세 정보 창에서 네트워크 인터페이스 탭을 클릭합니다.

- 버튼을 클릭하여 호스트 네트워크 설정 창을 엽니다.

- 물리적 호스트의 네트워크 인터페이스 옆에 있는 할당된 논리 네트워크 영역으로 선택 및 드래그하여 논리 네트워크를 물리적 호스트 네트워크 인터페이스에 연결합니다.다른 방법으로 논리 네트워크를 오른쪽 클릭하여 드롭 다운 메뉴에서 네트워크 인터페이스를 선택합니다.

- 논리 네트워크 설정:

- 할당된 논리 네트워크 위에 커서를 이동하고 연필 모양의 아이콘을 클릭하여 관리 네트워크 편집 창을 엽니다.

- 부트 프로토콜을 None, DHCP, 또는 Static 중에서 선택합니다. Static을 선택한 경우 IP, 넷마스크 / 라우팅 접두사, 그리고 게이트웨이를 입력합니다.

참고

각 논리 네트워크는 관리 네트워크 게이트웨이에서 정의된 다른 게이트웨이를 가질 수 있습니다. 이렇게 하면 논리 네트워크에 도착하는 트래픽이 관리 네트워크에서 사용되는 기본 게이트웨이가 아닌 논리 네트워크 게이트웨이를 사용하도록 전달됩니다. - 기본 호스트 네트워크 QoS를 덮어쓰기하려면 QoS 덮어쓰기를 선택하고 다음의 필드에 원하는 값을 입력합니다:

- 가중 공유: 같은 논리 링크에 연결된 다른 네트워크와 비교해서 어떤 특정 네트워크에 해당 논리 링크의 용량이 얼마나 할당되는지를 나타냅니다. 정확한 공유량은 해당 링크의 모든 네트워크의 총 공유량에 따라 다릅니다. 기본으로 이 수치는 1-100 범위에 있습니다.

- 속도 제한 [Mbps]: 네트워크가 사용하는 최대 대역폭입니다.

- 커밋 속도 [Mbps]: 네트워크가 필요로 하는 최소 대역폭입니다. 사용자가 요청하는 커밋 속도는 보장되지 않으며 네트워크 인프라와 같은 논리 링크에 있는 다른 네트워크에서 요청하는 커밋 속도에 따라 다릅니다.

호스트 네트워크 QoS 설정에 대한 자세한 정보는 2.3절. “호스트 네트워크 QoS”를 참조하십시오. - 네트워크 브릿지를 설정하려면 사용자 정의 속성 드롭 다운 메뉴를 클릭하고 를 선택합니다. 유효한 키와 [key]=[value]와 같은 구문으로된 값을 입력합니다. 여러 항목이 있을 경우 공백으로 구분합니다. 아래 예에서 제시된 값과 같이 다음과 같은 키가 유효합니다. 이러한 매개 변수에 대한 자세한 정보는 B.1절. “bridge_opts 매개 변수”을 참조하시기 바랍니다.

forward_delay=1500 gc_timer=3765 group_addr=1:80:c2:0:0:0 group_fwd_mask=0x0 hash_elasticity=4 hash_max=512 hello_time=200 hello_timer=70 max_age=2000 multicast_last_member_count=2 multicast_last_member_interval=100 multicast_membership_interval=26000 multicast_querier=0 multicast_querier_interval=25500 multicast_query_interval=13000 multicast_query_response_interval=1000 multicast_query_use_ifaddr=0 multicast_router=1 multicast_snooping=1 multicast_startup_query_count=2 multicast_startup_query_interval=3125

- ethtool 속성을 설정하려면 사용자 정의 속성 드롭 다운 메뉴를 클릭하고 를 선택합니다. 유효한 키와 [key]=[value]와 같은 구문으로된 값을 입력합니다. 여러 항목이 있을 경우 공백으로 구분합니다. 옵션은 기본으로 제공되지 않으며 engine 설정 도구를 사용해서 추가해야 합니다. 자세한 정보는 B.2절. “Ethtool 사용을 위해 Red Hat Virtualization Manager 설정”을 참조하시기 바랍니다. ethtool 속성에 대한 자세한 정보는 man 페이지를 참조하십시오.

- 논리 네트워크 정의가 호스트 상의 네트워크 설정과 동기화되어 있지 않을 경우 네트워크 동기화 확인란을 선택합니다. 논리 네트워크는 동기화되기전 까지 다른 인터페이스로 이동하거나 편집할 수 없습니다.

참고

네트워크가 다음 중 하나의 상태일 경우 동기화된 것으로 간주되지 않습니다:- 가상 머신 네트워크는 물리적 호스트 네트워크와 다른 경우.

- VLAN ID는 물리적 호스트 네트워크와 다른 경우.

- 사용자 정의 MTU는 논리 네트워크 상에 설정되어 물리적 호스트 네트워크와 다른 경우.

- 호스트와 Engine간의 연결을 확인 확인란을 선택하여 네트워크 연결 상태를 확인합니다. 이러한 동작은 호스트가 유지 관리 모드일 경우에만 작동합니다.

- 네트워크 설정 저장 확인란을 선택하여 시스템을 재부팅했을 경우 변경 사항을 영구적으로 저장합니다.

- 를 클릭합니다.

참고

5.5.3. 논리 네트워크를 사용하여 단일 네트워크 인터페이스에 여러 VLAN 추가

중요

절차 5.21. 논리 네트워크를 사용하여 네트워크 인터페이스에 여러 VLAN 추가

- 호스트 리소스 탭을 클릭하고 결과 목록에서 VLAN 태그 논리 네트워크가 할당된 클러스터에 연결된 호스트를 선택합니다.

- 상세 정보 창에서 네트워크 인터페이스 탭을 클릭하여 데이터 센터에 연결된 실제 네트워크 인터페이스를 나열합니다.

- 을 클릭하여 호스트 네트워크 설정 창을 엽니다.

- VLAN 태그 논리 네트워크를 물리 네트워크 인터페이스 옆에 있는 할당된 논리 네트워크 영역으로 드래그합니다. VLAN 태그로 물리 네트워크 인터페이스에 여러 논리 네트워크를 할당할 수 있습니다.

- 할당된 논리 네트워크 위에 커서를 이동하고 연필 모양의 아이콘을 클릭하여 네트워크 편집 창을 열고 논리 네트워크를 편집합니다.논리 네트워크 정의가 호스트 상의 네트워크 설정과 동기화되어 있지 않을 경우 네트워크 동기화 확인란을 선택합니다.다음에서 부팅 프로토콜을 선택합니다:OK를 클릭합니다.

- None,

- DHCP,

- Static,IP와 서브넷 마스크를 입력합니다.

- 호스트와 Engine간의 연결을 확인 확인란을 선택하여 네트워크를 확인합니다. 이러한 동작은 호스트가 유지 관리 모드일 경우에만 작동합니다.

- 네트워크 설정 저장 확인란을 선택합니다.

- 를 클릭합니다.

5.5.4. 네트워크 레이블을 호스트 네트워크 인터페이스에 추가

절차 5.22. 네트워크 레이블을 호스트 네트워크 인터페이스에 추가

- 호스트 리소스 탭을 클릭하고 결과 목록에서 VLAN 태그 논리 네트워크가 할당된 클러스터에 연결된 호스트를 선택합니다.

- 상세 정보 창에서 네트워크 인터페이스 탭을 클릭하여 데이터 센터에 연결된 실제 네트워크 인터페이스를 나열합니다.

- 을 클릭하여 호스트 네트워크 설정 창을 엽니다.

- 을 클릭하고 을 오른쪽 클릭합니다. 레이블할 실제 네트워크 인터페이스를 선택합니다.

- 레이블 텍스트 필드에서 네트워크 레이블 이름을 입력합니다.

- 를 클릭합니다.

5.5.5. 본딩

5.5.5.1. Red Hat Virtualization에서 본딩 로직

- 장치 중 하나가 이미 논리 네트워크를 전송하고 있습니까?

- 장치가 호환 가능한 논리 네트워크를 전송하고 있습니까?

표 5.7. 본딩 시나리오 및 결과

| 본딩 시나리오 | 결과 |

|---|---|

|

NIC + NIC

|

새로운 본딩 생성 창이 나타나면 새로운 본딩 장치를 설정할 수 있습니다.

네트워크 인터페이스가 호환되지 않는 논리 네트워크를 전송하는 경우 새로운 본딩을 구성한 장치에서 호환되지 않는 논리 네트워크를 분리할 때까지 본딩 작업은 실패합니다.

|

|

NIC + Bond

|

NIC가 본딩 장치에 추가됩니다. NIC 및 본딩에 의해 전송된 논리 네트워크는 호환 가능한 경우 모두 본딩 장치에 추가됩니다.

네트워크 인터페이스가 호환되지 않는 논리 네트워크를 전송하는 경우 새 본딩을 구성한 장치에서 호환되지 않는 논리 네트워크를 분리할 때 까지 본딩 작업은 실패합니다.

|

|

Bond + Bond

|

본딩 장치가 논리 네트워크에 연결되어 있지 않거나 호환 가능한 논리 네트워크에 연결되어 있을 경우 새 본딩 장치가 생성됩니다. 이에는 모든 네트워크 인터페이스가 포함되며 본딩 구성 장치의 모든 논리 네트워크를 전송합니다. 새로운 본딩 생성 창이 표시되어 새 본딩을 설정할 수 있습니다.

네트워크 인터페이스가 호환되지 않는 논리 네트워크를 전송하는 경우 새 본딩을 구성한 장치에서 호환되지 않는 논리 네트워크를 분리할 때 까지 본딩 작업은 실패합니다.

|

5.5.5.2. 본딩

중요

본딩 모드

모드 0 (round-robin 정책)- 네트워크 인터페이스 카드를 통해 순차적으로 패킷을 전송합니다. 패킷은 본딩에서 처음 사용 가능한 네트워크 인터페이스 카드로 시작하여 마지막으로 사용 가능한 네트워크 인터페이스 카드로 종료하는 루프에 전송됩니다. 이후의 모든 루프는 처음 사용 가능한 네트워크 인터페이스 카드에서 시작됩니다. 모드 0는 내결함성을 제공하고 본딩의 모든 네트워크 인터페이스 카드에서 부하 균형을 조정합니다. 하지만 모드 0는 브릿지와 함께 사용할 수 없으므로 가상 머신 논리 네트워크와 호환되지 않습니다.

모드 1 (active-backup 정책)- 하나의 네트워크 인터페이스 카드는 활성 상태로 두고 다른 모든 네트워크 인터페이스 카드를 백업 상태로 설정합니다. 활성 네트워크 인터페이스 카드에 오류가 발생하는 경우 백업 네트워크 인터페이스 카드 중 하나가 본딩에서 활성 네트워크 인터페이스 카드로 네트워크 인터페이스 카드를 대체합니다. 모드 1에서 본딩의 MAC 주소가 활성 네트워크 인터페이스 카드를 반영하도록 변경될 경우 발생할 수 있는 혼란을 방지하기 위해 MAC 주소는 하나의 포트에만 표시됩니다. 모드 1은 내결함성을 제공하고 Red Hat Virtualization에서 지원됩니다.

모드 2 (XOR 정책)- 소스에서 XOR 연산 결과 및 대상 MAC 주소 모듈 네트워크 인터페이스 카드 슬레이브 수에 따라 패킷을 전송할 네트워크 인터페이스 카드를 선택합니다. 이러한 계산을 통해 각각의 대상 MAC 주소에 동일한 네트워크 인터페이스 카드가 선택됩니다. 모드 2는 내결함성 및 부하 분산을 제공하고 Red Hat Virtualization에서 지원됩니다.

모드 3 (broadcast 정책)- 모든 네트워크 인터페이스 카드에 모든 패킷을 전송합니다. 모드 3은 내결함성을 제공하고 Red Hat Virtualization에서 지원됩니다.

모드 4 (IEEE 802.3ad 정책)- 인터페이스가 동일한 속도 및 이중 설정을 공유하는 집계 그룹을 생성합니다. 모드 4는 IEEE 802.3ad 사양에 따라 활성 집계 그룹에 있는 모든 네트워크 인터페이스 카드를 사용하며 Red Hat Virtualization에서 지원됩니다.

모드 5 (adaptive transmit load balancing 정책)- 본딩의 각 네트워크 인터페이스 카드에서 부하에 따라 발신 트래픽 계정이 분산되어 현재 네트워크 인터페이스 카드가 모든 들어오는 트래픽을 수신할 수 있게 합니다. 수신 트래픽에 할당된 네트워크 인터페이스 카드에 오류가 발생할 경우 다른 네트워크 인터페이스 카드가 수신 트래픽의 역할을 하도록 지정됩니다. 모드 5는 브리지와 함께 사용할 수 없으므로 가상 머신 논리 네트워크와 호환되지 않습니다.

모드 6 (adaptive load balancing 정책)- 특별한 전환 요구 사항없이 모드 5 (adaptive transmit load balancing 정책)는 IPv4 트래픽의 수신 부하 분산과 결합되어 있습니다. ARP 협상은 수신 부하 분산에 사용됩니다. 모드 6는 브리지와 함께 사용할 수 없으므로 가상 머신 논리 네트워크와 호환되지 않습니다.

5.5.5.3. 관리 포털에서 본딩 장치 생성

절차 5.23. 관리 포털에서 본딩 장치 생성

- 호스트 리소스 탭을 클릭하여 결과 목록에서 호스트를 선택합니다.

- 상세 정보 창에서 네트워크 인터페이스 탭을 클릭하여 호스트에 연결된 실제 네트워크 인터페이스를 나열합니다.

- 을 클릭하여 호스트 네트워크 설정 창을 엽니다.

- 한 장치를 선택하고 다른 장치에 드래그하여 드롭하면 새로운 본딩 생성 창이 열립니다. 다른 방법으로 장치 위에 마우스를 두고 오른쪽을 클릭한 후 드롭 다운 메뉴에서 다른 장치를 선택합니다.장치가 호환되지 않는 경우 본딩 작업이 실패하며 호환 문제를 해결하는 방법을 알려주는 메시지가 나타납니다.

- 드롭 다운 메뉴에서 본딩 이름 및 본딩 모드를 선택합니다.본딩 모드 1, 2, 4, 5를 선택할 수 있습니다. 기타 다른 모드는 사용자 정의 옵션을 사용하여 설정할 수 있습니다.

- 를 클릭하여 본딩을 생성하고 새로운 본딩 생성 창을 닫습니다.

- 새로 생성된 본딩 장치에 논리 네트워크를 지정합니다.

- 옵션으로 호스트와 Engine 간의 연결을 확인을 선택하고 네트워크 설정 저장을 선택합니다.

- 를 클릭하여 변경 사항을 저장하고 호스트 네트워크 설정 창을 닫습니다.

5.5.5.4. 호스트 인터페이스의 사용자 정의 본딩 옵션 사용 예

예 5.1. xmit_hash_policy

mode=4 xmit_hash_policy=layer2+3

예 5.2. ARP 모니터링

arp_interval을 설정합니다:

mode=1 arp_interval=1 arp_ip_target=192.168.0.2

예 5.3. 기본

mode=1 primary=eth0

5.5.6. 호스트의 FQDN 변경

절차 5.24. 호스트의 FQDN 업데이트

- 호스트를 유지 관리 모드에 두면 가상 머신이 다른 호스트로 라이브 마이그레이션됩니다. 보다 자세한 내용은 6.5.8절. “호스트를 유지 관리 모드로 변경”에서 참조하십시오. 다른 방법으로 전체 가상 머신을 수동으로 종료하고 다른 호스트로 모든 가상 머신을 마이그레이션합니다. 보다 자세한 내용은 Virtual Machine Management Guide에 있는 Manually Migrating Virtual Machines에서 참조하십시오.

- 를 클릭하고 를 클릭하여 관리 포털에서 호스트를 삭제합니다.

- hostnamectl 도구를 사용하여 호스트 이름을 업데이트합니다. 보다 자세한 옵션은 Red Hat Enterprise Linux 7 네트워킹 가이드의 호스트 이름 설정에서 참조하십시오.

# hostnamectl set-hostname NEW_FQDN

- 호스트를 재부팅합니다.

- Manager로 호스트를 다시 등록합니다. 보다 자세한 내용은 6.5.1절. “Red Hat Virtualization Manager에 대한 Host 추가”에서 참조하십시오.

5.5.7. 호스트의 IP 주소 변경

절차 5.25.

- 호스트를 유지 관리 모드에 두면 가상 머신이 다른 호스트로 라이브 마이그레이션됩니다. 보다 자세한 내용은 6.5.8절. “호스트를 유지 관리 모드로 변경”에서 참조하십시오. 다른 방법으로 전체 가상 머신을 수동으로 종료하고 다른 호스트로 모든 가상 머신을 마이그레이션합니다. 보다 자세한 내용은 Virtual Machine Management Guide에 있는 Manually Migrating Virtual Machines에서 참조하십시오.

- 를 클릭하고 를 클릭하여 관리 포털에서 호스트를 삭제합니다.

admin사용자로 호스트에 로그인합니다.- F2를 누르고 를 선택한 후 Enter를 눌러 복구 쉘로 들어갑니다.

/etc/sysconfig/network-scripts/ifcfg-ovirtmgmt파일을 편집하여 IP 주소를 수정합니다. 예:# vi /etc/sysconfig/network-scripts/ifcfg-ovirtmgmt ... BOOTPROTO=none IPADDR=10.x.x.x PREFIX=24 ...

- 네트워크 서비를 다시 시작하고 IP 주소가 업데이트되었는지 확인합니다.

# systemctl restart network.service

# ip addr show ovirtmgmt

exit을 입력하여 복구 쉘에서 나간 후 텍스트 사용자 인터페이스로 전환합니다.- Manager로 호스트를 다시 등록합니다. 보다 자세한 내용은 6.5.1절. “Red Hat Virtualization Manager에 대한 Host 추가”에서 참조하십시오.

6장. 호스트

6.1. 호스트 소개

참고

- 시스템에 있는 하나의 클러스터에만 속해 있어야 합니다.

- AMD-V 또는 Intel VT 하드웨어 가상화 확장 기능을 지원하는 CPU가 있어야 합니다.

- 클러스터 생성 시 선택한 가상 CPU 유형으로 공개된 모든 기능을 지원하는 CPU가 있어야 합니다.

- 최소 2 GB RAM이 있어야 합니다.

- 시스템 권한이 있는 시스템 관리자를 지정해야 합니다.

주의

nmcli, nmtui, 그리고 Cockpit 사용자 인터페이스 포함)를 사용한 네트워킹 설정은 현재 지원되지 않습니다. Manager에 호스트를 추가하기 전에 추가 네트워크 설정이 필요한 경우 수동으로 ifcfg 파일을 씁니다. 보다 자세한 내용은 Red Hat Enterprise Linux Networking Guide를 참조하십시오.

6.2. Red Hat Virtualization Host

yum을 사용해서 업데이트할 수 있습니다. 하지만 추가 패키지를 설치하는 것은 현재 지원되지 않으며 추가로 설치된 패키지는 RHVH 업데이트 시 매번 다시 설치되어야 합니다.

참고

grubby 도구를 사용하여 사용자 설정 커널 인수를 Red Hat Virtualization Host에 추가할 수 있습니다. grubby 도구는 grub.cfg 파일의 변경 사항을 영구적으로 적용합니다. 호스트의 Cockpit 사용자 인터페이스의 도구 > 터미널 하위 탭으로 가서 grubby 명령을 사용합니다. 보다 자세한 내용은 Red Hat Enterprise Linux System Administrator's Guide에서 참조하십시오.

6.3. Red Hat Enterprise Linux 호스트

Red Hat Enterprise Linux Server 인타이틀먼트 및 Red Hat Virtualization 인타이틀먼트에 연결해야 합니다.

중요

6.4. Satellite 호스트 공급자 호스트

6.5. 호스트 작업

6.5.1. Red Hat Virtualization Manager에 대한 Host 추가

절차 6.1. Red Hat Virtualization Manager에 대한 Host 추가

- 관리 포털에서 호스트 리소스 탭을 클릭합니다.

- 를 클릭합니다.

- 드롭 다운 목록을 사용하여 새 호스트의 데이터 센터 및 호스트 클러스터를 선택합니다.

- 새 호스트의 이름과 주소를 입력합니다. SSH 포트 란에 표준 SSH 포트인 포트 22가 자동으로 채워집니다.

- Manager가 호스트에 액세스 시 인증방법을 선택합니다.

- 인증 암호를 사용하기 위해 root 사용자 암호를 입력합니다.

- 또는, SSH 공개키 필드에 표시된 키를 호스트에 있는

/root/.ssh/authorized_keys에 복사하여 공개키 인증에 사용합니다.

- 버튼을 클릭해서 고급 호스트 설정을 표시합니다.

- 옵션으로 자동 방화벽 설정을 비활성화합니다.

- 옵션으로 JSON 프로토콜 사용을 비활성화합니다.

- 옵션으로 보안을 강화하기 위해 호스트 SSH 지문을 추가합니다. 이를 수동으로 추가하거나 자동으로 가져오기할 수 있습니다.

- 옵션으로 전원 관리를 설정하는 경우 호스트에 지원되는 전원 관리 카드가 있어야 합니다. 전원 관리 설정에 대한 정보는 6.5.4.2절. “호스트 전원 관리 설정”을 참조하시기 바랍니다.

- 를 클릭합니다.

Installing 상태로 호스트 목록에 표시되고 상세 정보 창에서 설치 진행 상태를 확인할 수 있습니다. 잠시 후 호스트 상태가 Up으로 변경됩니다.

6.5.2. Satellite 호스트 공급자 호스트 추가

절차 6.2. Satellite 호스트 공급자 호스트 추가

- 호스트 리소스 탭을 클릭하여 결과 목록에 호스트를 나열합니다.

- 를 클릭하여 새 호스트 창을 엽니다.

- 드롭 다운 메뉴를 사용하여 새 호스트의 호스트 클러스터를 선택합니다.

- Foreman/Satellite 확인란을 선택하여 Satellite 호스트 공급자 호스트를 추가하기 위한 옵션을 표시하고 호스트를 추가할 공급자를 선택합니다.

- 검색된 호스트 또는 프로비저닝된 호스트를 선택합니다.

- 검색된 호스트 (기본 옵션): 드롭 다운 메뉴에서 호스트, 호스트 그룹, 컴퓨터 리소스를 선택합니다.

- 프로비저닝된 호스트: 공급자 호스트 드롭 다운 메뉴에서 호스트를 선택합니다.

외부 공급자에서 검색할 수 있는 호스트에 관한 모든 세부 사항은 자동으로 설정되어 원하는 대로 편집할 수 있습니다. - 새 호스트의 이름, 주소, SSH 포트 (프로비저닝된 호스트만)를 입력합니다.

- 호스트에 사용할 인증 방식을 선택합니다.

- 인증 암호를 사용하기 위해 root 사용자 암호를 입력합니다.

- SSH 공개키 필드에 표시된 키를 호스트에 있는

/root/.ssh/authorized_hosts에 복사하여 공개키 인증에 사용합니다 (프로비저닝된 호스트만 해당).

- Red Hat Enterprise Linux 호스트를 추가하기 위한 필수 단계를 완료했습니다. 드롭 다운 메뉴 버튼을 클릭하여 고급 호스트 설정을 표시합니다.

- 옵션으로 자동 방화벽 설정을 비활성화합니다.

- 옵션으로 JSON 프로토콜 사용을 비활성화합니다.

- 옵션으로 보안을 강화하기 위해 호스트 SSH 지문을 추가합니다. 이를 수동으로 추가하거나 자동으로 가져오기할 수 있습니다.

- 해당 탭을 통해 전원 관리, SPM, 콘솔, 네트워크 공급자를 설정할 수 있습니다. 하지만 이러한 설정은 Red Hat Enterprise Linux 호스트를 추가하는데 필요하지 않기 때문에 이 부분에서는 설명하지 않습니다.

- 를 클릭하여 호스트를 추가하고 창을 닫습니다.

Installing 상태로 호스트 목록에 표시되고 상세 정보 창에서 설치 진행 상태를 확인할 수 있습니다. 설치 완료 후 상태는 Reboot가 됩니다. 상태를 Up으로 변경하기 위해 호스트를 활성화해야 합니다.

6.5.3. 호스트에 대한 Satellite 에라타 관리 설정

중요

절차 6.3. 호스트에 대한 Satellite 에라타 관리 설정

- Satellite 서버를 외부 공급자로 추가합니다. 보다 자세한 내용은 11.2.1절. “호스트 프로비저닝을 위한 Red Hat Satellite 인스턴스 추가”에서 참조하십시오.

- 필요한 호스트를 Satellite 서버에 연결합니다.

참고

호스트는 해당 Satellite 서버에 등록되어 있고 katello-agent 패키지가 설치되어야 합니다.호스트 등록 설정 방법에 대한 보다 자세한 내용은 Red Hat Satellite User Guide에 있는 Configuring a Host for Registration에서 참조하고 호스트 등록 및 katello-agent 패키지 설치에 대한 보다 자세한 내용은 Red Hat Satellite User Guide에 있는 Registration에서 참조하시기 바랍니다.- 호스트 탭에서 결과 목록에 있는 호스트를 선택합니다.

- 을 클릭하여 호스트 편집 창을 엽니다.

- Check the 체크 상자를 선택합니다.

- 드롭 다운 목록에서 원하는 Satellite 서버를 선택합니다.

- 를 클릭합니다.

6.5.4. 새 호스트 및 호스트 편집 창 설정 및 제어

6.5.4.1. 호스트 일반 설정

표 6.1. 일반 설정

|

필드 이름

|

설명

|

|---|---|

|

데이터 센터

|

호스트가 속한 데이터 센터입니다. Red Hat Virtualization Host(RHVH)는 Gluster-활성 클러스터에 추가할 수 없습니다.

|

|

호스트 클러스터

|

호스트가 속한 클러스터입니다.

|

|

Foreman/Satellite 사용

|

이 확인란을 선택 또는 선택 해제하여 Satellite 호스트 공급자가 제공하는 호스트를 추가하기 위한 옵션을 표시 또는 숨기기합니다. 다음과 같은 옵션도 사용 가능합니다:

검색된 호스트

프로비저닝된 호스트

|

|

이름

|

클러스터 이름입니다. 텍스트 필드는 최대 40 자로 제한되어 있으며 알파벳 대문자, 소문자, 숫자, 하이픈, 밑줄로 조합된 고유한 이름이어야 합니다.

|

|

코멘트

|

호스트 관련 일반 텍스트 형식의 사용자가 읽을 수 있는 코멘트를 추가하기 위한 필드입니다.

|

|

주소

|

IP 주소 또는 확인 가능한 호스트의 호스트 이름입니다.

|

|

암호

|

호스트의 root 사용자 암호입니다. 호스트 추가 시에만 지정할 수 있으며 그 이후에는 편집할 수 없습니다.

|

|

SSH 공개키

|

호스트 인증을 위해 암호를 사용하는 대신 Manager의 SSH 키를 사용하는 경우 호스트에 있는

/root/.known_hosts 파일에 텍스트 상자의 내용을 복사합니다.

|

|

호스트 방화벽 자동 설정

|

새 호스트를 추가 할 때 Manager는 호스트의 방화벽에 필요한 포트를 열 수 있습니다. 이 옵션은 기본적으로 활성화되어 있습니다. 이는 고급 매개 변수입니다.

|

|

JSON 프로토콜 사용

|

이 옵션은 기본적으로 활성화되어 있습니다. 이는 고급 매개 변수입니다.

|

|

SSH 지문

|

호스트의 SSH 지문을 하여 호스트가 반환할 것으로 예상하는 지문과 일치하는지 비교할 수 있습니다. 이는 고급 매개 변수입니다.

|

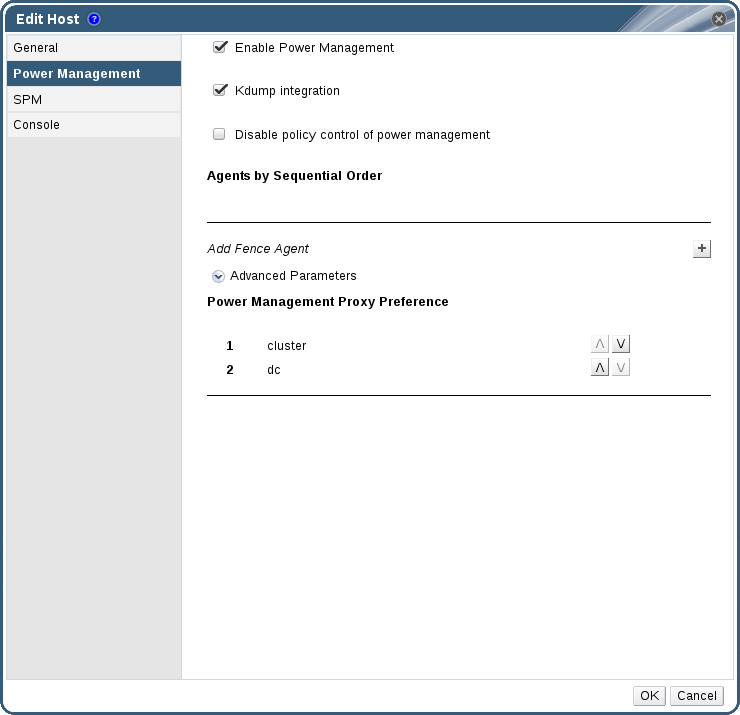

6.5.4.2. 호스트 전원 관리 설정

표 6.2. 전원 관리 설정

|

필드 이름

|

설명

|

|---|---|

|

전원 관리 활성화

|

호스트에서 전원 관리를 활성화합니다. 이 확인란을 선택하여 전원 관리 탭에 있는 나머지 필드를 활성화합니다.

|

|

Kdump 통합

|

커널 크래시 덤프를 수행하는 동안 호스트가 펜싱되지 않도록 하여 크래시 덤프가 중단되지 않도록 합니다. Red Hat Enterprise Linux 7.1 이상에서 kdump는 기본값으로 사용 가능합니다. 호스트에서 Kdump를 사용할 수 있지만 설정이 유효하지 않은 (kdump 서비스를 시작할 수 없는)경우 Kdump 통합을 사용하면 호스트 설치에 실패하게 됩니다. 이러한 경우 6.6.4절. “fence_kdump 고급 설정”에서 참조하십시오.

|

|

전원 관리 정책 제어를 비활성화

|

전원 관리는 호스트 클러스터의 스케줄링 정책에 의해 제어됩니다. 전원 관리를 활성화하고 지정된 사용량 하한치에 도달한 경우 Manager는 호스트 머신의 전원을 종료하고 부하 분산이 필요하거나 클러스터에 여유 호스트가 충분하지 않을 경우 호스트를 다시 시작합니다. 이 확인란을 선택하여 정책 제어를 비활성화합니다.

|

|

순서대로 정렬된 에이전트

|

호스트의 펜스 에이전트를 나열합니다. 펜스 에이전트는 순차적으로나 동시에 또는 이 두가지를 혼합하여 사용할 수 있습니다.

기본값으로 펜스 에이전트는 순차적으로 사용됩니다. 위, 아래 버튼을 사용하여 사용할 펜스 에이전트 순서를 변경합니다.

두 개의 펜스 에이전트를 동시에 사용하려면 다른 펜스 에이전트 옆에 있는 동시 사용 에이전트 드롭 다운 목록에서 하나의 펜스 에이전트를 선택합니다. 추가 펜스 에이전트 옆에 있는 동시 사용 에이전트 드롭 다운 목록에서 그룹을 선택하여 동시에 사용할 펜스 에이전트 그룹에 추가 펜스 에이전트를 추가할 수 있습니다.

|

|

펜스 에이전트 추가

|

플러스 () 버튼을 클릭하여 새 펜싱 에이전트를 추가합니다. 펜스 에이전트 편집 창이 열립니다. 다음 표에는 이 창에 있는 필드에 대한 자세한 설명이 있습니다.

|

|

전원 관리 프록시 설정

|

기본값으로 Manager는 호스트와 동일한 cluster 내에 있는 펜싱 프록시를 검색하도록 지정되며 펜싱 프록시가 검색되지 않을 경우 Manager는 동일한 dc (데이터 센터)에서 검색합니다. 위, 아래 버튼을 사용하여 이러한 리소스의 사용 순서를 변경합니다. 이 필드는 고급 매개 변수 아래에 있습니다.

|

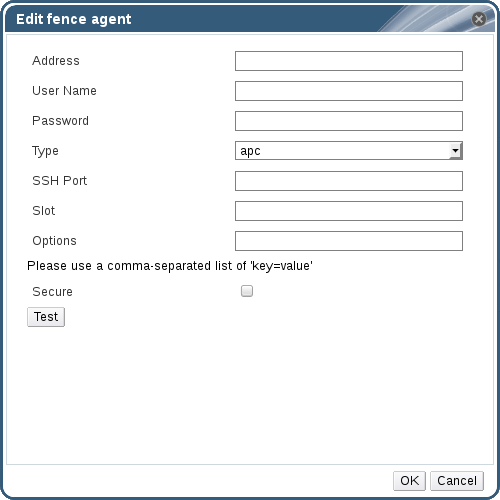

표 6.3. 펜스 에이전트 편집 설정

|

필드 이름

|

설명

|

|---|---|

|

주소

|

호스트의 전원 관리 장치에 액세스하기 위한 주소입니다. 확인 가능한 호스트 이름 또는 IP 주소입니다.

|

|

사용자 이름

|

전원 관리 장치에 액세스하기 위한 사용자 계정입니다. 장치에 사용자를 설정하거나 기본 사용자를 사용할 수 있습니다.

|

|

암호

|

전원 관리 장치에 액세스하기 위한 사용자 암호입니다.

|

|

유형

|

호스트의 전원 관리 장치 유형입니다.

다음 중 하나를 선택합니다:

|

|

SSH 포트

|

전원 관리 장치가 호스트와의 통신에 사용하는 포트 번호입니다.

|

|

슬롯

|

전원 관리 장치의 블레이드를 구별하기 위해 사용하는 번호입니다.

|

|

서비스 프로파일

|

전원 관리 장치의 블레이드를 구별하기 위해 사용하는 서비스 프로파일 이름입니다. 이 필드는 장치 유형이

cisco_ucs일 때 슬롯 대신 나타납니다.

|

|

옵션

|

전원 관리 장치 관련 옵션입니다. 'key=value'로 입력합니다. 사용 가능한 옵션은 호스트의 전원 관리 장치 관련 문서에서 참조하십시오.

Red Hat Enterprise Linux 7 호스트의 경우 전원 관리 장치로 cisco_ucs를 사용하고 있을 경우 옵션 필드에

ssl_insecure=1을 추가해야 합니다.

|

|

보안

|

이 확인란을 선택하여 전원 관리 장치를 호스트에 안전하게 연결합니다. 이는 전원 관리 에이전트에 따라 ssh, ssl, 기타 다른 인증 프로토콜을 통해 실행될 수 있습니다.

|

6.5.4.3. SPM 우선순위 설정

표 6.4. SPM 설정

|

필드 이름

|

설명

|

|---|---|

|

SPM 우선순위

|

SPM (Storage Pool Manager) 역할이 지정된 호스트의 우선순위를 정의합니다. 우선순위 옵션에는 낮음, 보통, 높음이 있습니다. 낮은 우선순위는 해당 호스트에 SPM 역할이 할당될 수 있는 가능성이 낮아지고 높은 우선순위는 가능성이 높아짐을 의미합니다. 기본 설정은 보통입니다.

|

6.5.4.4. 호스트 콘솔 설정

표 6.5. 콘솔 설정

|

필드 이름

|

설명

|

|---|---|

|

출력 주소 덮어쓰기

|

이 체크 상자를 선택하여 호스트의 디스플레이 주소를 덮어쓰기합니다. 이 기능은 호스트가 내부 IP로 정의되어 있고 NAT 방화벽을 사용하고 있을 경우 유용합니다. 사용자가 내부 네트워크의 외부에서 가상 머신에 연결할 때 가상 머신을 실행하고 있는 호스트의 비공개 주소를 반환하지 않고 공용 IP 또는 FQDN을 (공용 IP의 외부 네트워크에서 확인됨) 반환합니다.

|

|

주소 출력

|

여기에 지정된 디스플레이 주소는 이 호스트에서 실행되는 모든 가상 머신에 사용됩니다. 주소는 완전 정규화된 도메인 이름이나 IP 주소 형식이어야 합니다.

|

6.5.5. 호스트 전원 관리 기능 설정

중요

maintenance mode인지 확인합니다. 호스트가 이 모드에 있지 않을 경우 해당 호스트에서 실행되는 모든 가상 머신은 호스트를 다시 시작할 때 중단되어 제품 환경에 장애가 발생할 수 있습니다. 호스트가 maintenance mode로 올바르게 설정되어 있지 않은 경우 경고 메세지가 표시됩니다.

절차 6.4. 전원 관리 설정

- 호스트 탭에서 결과 목록에 있는 호스트를 선택합니다.

- 을 클릭하여 호스트 편집 창을 엽니다.

- 전원 관리 탭을 클릭하여 전원 관리 설정을 표시합니다.

- 필드를 활성화하려면 전원 관리 활성화 확인란을 선택합니다.

- Kdump 통합 확인란을 선택하여 커널 크래시 덤프 실행 시 호스트가 차단되지 않게 합니다.

중요

기존 호스트에서 Kdump 통합을 활성화할 때 kdump를 설정하기 위해 호스트를 다시 설치해야 합니다. 6.5.11절. “호스트 다시 설치”에서 참조하십시오. - 옵션으로 호스트의 전원 관리가 호스트 클러스터의 스케줄링 정책에 의해 제어되지 않게 하려면 전원 관리 정책 제어를 비활성화 확인란을 선택합니다.

- 플러스 () 버튼을 클릭하여 새 전원 관리 장치를 추가합니다. 펜스 에이전트 편집 창이 열립니다.

- 해당 란에 전원 관리 장치의 주소, 사용자 이름, 암호를 입력합니다.

- 드롭 다운 목록에서 전원 관리 장치 유형을 선택합니다.

- 전원 관리 장치가 사용하는 SSH 포트 번호를 입력하여 호스트와 통신합니다.

- 전원 관리 장치의 블레이드를 구별하기 위해 사용하는 슬롯 번호를 입력합니다.

- 전원 관리 장치의 옵션을 입력합니다. 콤마로 구분된 'key=value' 항목을 사용합니다.

- 보안 확인란을 선택하여 호스트에 안전하게 연결하는 전원 관리 장치를 활성화합니다.

- 를 클릭하여 설정이 올바른지 확인합니다. 작업 완료 후 Test Succeeded, Host Status is: on이 표시됩니다.

- 를 클릭하여 펜스 에이전트 편집 창을 닫습니다.

- 전원 관리 탭에서 옵션으로 고급 매개변수를 확장하고 위, 아래 버튼을 사용하여 Manager가 펜싱 프록시 용으로 호스트의 클러스터 및 dc (datacenter)를 검색할 순서를 지정합니다.

- 를 클릭합니다.

6.5.6. 호스트의 Storage Pool Manager 설정

절차 6.5. SPM 항목 설정

- 호스트 리소스 탭을 클릭하여 결과 목록에서 호스트를 선택합니다.

- 을 클릭하여 호스트 편집 창을 엽니다.

- SPM 탭을 클릭하여 SPM 우선순위 설정을 표시합니다.

- 라디오 버튼을 사용하여 호스트에 대해 알맞는 SPM 우선순위를 선택합니다.

- 를 클릭하여 설정을 저장하고 창을 닫습니다.

6.5.7. 리소스 편집

절차 6.6. 리소스 편집

- 리소스 탭, 트리 모드 또는 검색 기능을 사용하여 검색 결과 목록에서 리소스를 검색 및 선택합니다.

- 을 클릭하여 편집 창을 엽니다.

- 필요한 속성을 변경하고 를 클릭합니다.

6.5.8. 호스트를 유지 관리 모드로 변경

절차 6.7. 호스트를 유지 관리 모드로 전환

- 호스트 리소스 탭을 클릭하여 원하는 호스트를 선택합니다.

- 를 클릭하면 호스트 유지관리 모드 확인 창이 열립니다.

- 옵션으로 호스트 유지관리 모드 확인 창에서 호스트를 유지 관리 모드로 전환하려는 이유를 입력합니다. 이를 통해 유지 관리 에 대한 설명을 제공할 수 있으며 이는 로그에 호스트가 다시 활성화될 때에 표시됩니다.

참고

호스트 유지 관리 이유 필드는 클러스터 설정에서 활성화되어 있는 경우에만 표시됩니다. 보다 자세한 내용은 4.2.2.1절. “일반 클러스터 설정”에서 참조하십시오. - 를 클릭하여 유지 관리 모드를 시작합니다.

Preparing for Maintenance로 변경되고 작업이 성공적으로 완료되면 Maintenance로 됩니다. VDSM은 호스트가 유지 관리 모드일 경우 중지되지 않습니다.

참고

6.5.9. 유지 관리 모드에서 호스트 활성화

Unassigned로 변경하고 작업 완료되면 Up 상태가 됩니다. 이제 가상 머신을 호스트에서 실행할 수 있습니다. 호스트가 유지 보수 모드로 되어 있을 때 다른 호스트로 마이그레이션된 가상 머신은 활성화 시 호스트에 자동으로 마이그레이션 반환되지 않지만 수동으로 마이그레이션할 수 있습니다. 호스트를 유지 관리 모드로 변경하기 전 호스트가 SPM (Storage Pool Manager)인 경우 호스트 활성화 시 SPM 역할은 자동으로 반환되지 않습니다.

6.5.10. 호스트 삭제

절차 6.9. 호스트 삭제

- 관리 포털에서 호스트 리소스 탭을 클릭하고 결과 목록에서 호스트를 선택합니다.

- 호스트를 유지 관리 모드로 변경합니다.

- 를 클릭하면 호스트 삭제 확인 창이 열립니다.

- 호스트가 Red Hat Gluster Storage 클러스터의 부분으로 볼륨 브릭이 있거나 호스트가 응답하지 않는 경우 강제 삭제 확인란을 선택합니다.

- 를 클릭합니다.

6.5.11. 호스트 다시 설치

중요

절차 6.10. Red Hat Virtualization Host 또는 Red Hat Enterprise Linux 호스트 다시 설치

- 호스트 리소스 탭, 트리 모드 또는 검색 기능을 사용하여 검색 결과 목록에서 호스트를 검색 및 선택합니다.

- 를 클릭합니다. 클러스터 레벨에서 마이그레이션이 활성화되어 있을 경우 호스트에서 실행되고 있는 가상 머신은 다른 호스트로 마이그레이셔됩니다. 호스트가 SPM일 경우 이 그능은 다른 호스트로 이동합니다. 호스트가 유지 관리 모드가 되면 호스트 상태가 변경됩니다.

- 다시 설치를 클릭하여 호스트 설치 창을 엽니다.

- 를 클릭하여 호스트를 다시 설치합니다.

중요

6.5.12. 태그로 호스트를 사용자 정의하기

절차 6.11. 태그로 호스트를 사용자 정의하기

- 호스트 리소스 탭, 트리 모드 또는 검색 기능을 사용하여 검색 결과 목록에서 호스트를 검색 및 선택합니다.

- 을 클릭하여 태그 지정 창을 엽니다.

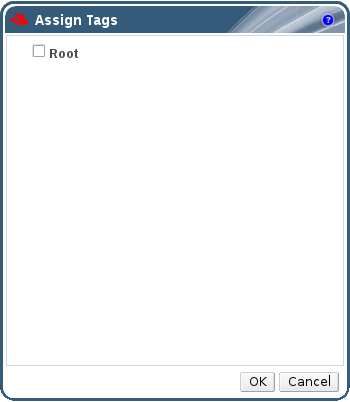

- 태그 지정 창에틑 사용가능한 모든 태그가 나열됩니다. 해당 태그의 체크 상자를 선택합니다.

- 를 클릭하여 태그를 지정하고 창을 닫습니다.

6.5.13. 호스트 에라타 표시

절차 6.12. 호스트 에라타 표시

- 호스트 리소스 탭을 클릭하여 결과 목록에서 호스트를 선택합니다.

- 상세 정보 창의 일반 탭을 클릭합니다.

- 일반 탭에서 에라타 하위 탭을 클릭합니다.

6.5.14. 호스트 상태 표시

- OK: 아이콘 없음

- Info:

- Warning:

- Error:

- Failure:

GET 요청에는 호스트 상태가 들어 있는 external_status 요소가 포함됩니다.

events 컬렉션을 통해 REST API에서 호스트 상태를 설정할 수 있습니다. 자세한 정보는 REST API Guide에 있는 Adding Events에서 참조하십시오.

6.5.15. 호스트 장치 표시

절차 6.13. 호스트 장치 표시

- 호스트 리소스 탭, 트리 모드 또는 검색 기능을 사용하여 검색 결과 목록에서 호스트를 검색 및 선택합니다.

- 상세 정보 창에서 호스트 장치 탭을 클릭합니다.

6.5.16. GPU 통과(Passthrough)에 필요한 호스트 및 게스트 시스템 준비

grub 설정 파일을 수정해야 합니다. 두 시스템 모두 다시 시작해서 변경 사항을 적용합니다.

절차 6.14. GPU 통과(Passthrough)에 필요한 호스트 준비

- 호스트 서버에 로그인하고 vendor ID:product ID 장치를 찾습니다.다음의 예시에서 사용된 ID는

10de:13ba및10de:0fbc입니다.# lspci -nn ... 01:00.0 VGA compatible controller [0300]: NVIDIA Corporation GM107GL [Quadro K2200] [10de:13ba] (rev a2) 01:00.1 Audio device [0403]: NVIDIA Corporation Device [10de:0fbc] (rev a1) ...

- grub 설정 파일 편집 후

GRUB_CMDLINE_LINUX행 뒤에 pci-stub.ids=xxxx:xxxx를 덧붙입니다.# vi /etc/default/grub ... GRUB_CMDLINE_LINUX="nofb splash=quiet console=tty0 ... pci-stub.ids=10de:13ba,10de:0fbc" ...

호스트에서 해당하는 드라이버를 블랙리스트에 추가합니다. 다음의 예시에서는GRUB_CMDLINE_LINUX행을 추가로 수정해서 nVidia의 nouveau driver가 블랙리스트에 추가됩니다.# vi /etc/default/grub ... GRUB_CMDLINE_LINUX="nofb splash=quiet console=tty0 ... pci-stub.ids=10de:13ba,10de:0fbc rdblacklist=nouveau" ...

grub설정 파일을 저장합니다. - 변경 사항을 반영하기 위해

grub.cfg파일을 새로고침하고 서버를 재부팅합니다:# grub2-mkconfig -o /boot/grub2/grub.cfg

# reboot

lspci명령을 사용해서 장치의pci-stub드라이버 연결을 확인합니다:# lspci -nnk ... 01:00.0 VGA compatible controller [0300]: NVIDIA Corporation GM107GL [Quadro K2200] [10de:13ba] (rev a2) Subsystem: NVIDIA Corporation Device [10de:1097] Kernel driver in use: pci-stub 01:00.1 Audio device [0403]: NVIDIA Corporation Device [10de:0fbc] (rev a1) Subsystem: NVIDIA Corporation Device [10de:1097] Kernel driver in use: pci-stub ...

절차 6.15. GPU 통과(Passthrough)에 필요한 게스트 가상 머신 준비

- Linux의 경우

- 독점 GPU 드라이버만 지원됩니다. 해당되는 오픈소스 드라이버를

grub설정 파일의 블랙리스트에 추가합니다. 예:$ vi /etc/default/grub ... GRUB_CMDLINE_LINUX="nofb splash=quiet console=tty0 ... rdblacklist=nouveau" ...

- GPU BusID를 찾습니다. 다음의 예시에서 BusID는

00:09.0입니다.# lspci | grep VGA 00:09.0 VGA compatible controller: NVIDIA Corporation GK106GL [Quadro K4000] (rev a1)

/etc/X11/xorg.conf파일을 편집하여 다음 내용을 추가합니다:Section "Device" Identifier "Device0" Driver "nvidia" VendorName "NVIDIA Corporation" BusID "PCI:0:9:0" EndSection

- 가상 머신을 다시 시작합니다.

- Windows의 경우

- 장치에 해당되는 드라이버를 다운로드하여 설치합니다. 예를 들어 Nvidia 드라이버의 경우 NVIDIA Driver Downloads로 갑니다.

- 가상 머신을 다시 시작합니다.

6.5.17. 관리 포털에서 Cockpit 액세스

절차 6.16. 관리 포털에서 Cockpit 액세스

- Manager 시스템에 Cockpit UI 플러그인을 설치합니다:

# yum install cockpit-ovirt-uiplugin

- 관리 포털에서 호스트 탭을 클릭하고 호스트를 선택합니다.

- 새 탭에서 Cockpit 사용자 인터페이스를 열거나 관리 포털에서 바로 표시합니다:

- 호스트을 오른쪽 클릭하고 을 선택하면 새 브라우저 탭에서 Cockpit 사용자 인터페이스가 열립니다.

- Cockpit 하위 탭을 클릭하여 Hosts 탭의 상세 정보 창에 Cockpit 사용자 인터페이스를 표시합니다.

참고

선택한 호스트에서 Cockpit을 사용할 수 없는 경우 Cockpit 하위 탭에 기본적인 문제 해결 방법이 설명되어 있습니다.

6.6. 호스트 복원

6.6.1. 호스트 고가용성

6.6.2. Red Hat Virtualization에서 프록시를 통해 전원 관리

- 펜싱이 필요한 호스트와 동일한 클러스터에 있는 호스트입니다.

- 펜싱이 필요한 호스트와 동일한 데이터 센터에 있는 호스트입니다.

6.6.3. 호스트에서 펜싱 매개 변수 설정

절차 6.17. 호스트에서 펜싱 매개 변수 설정

- 호스트 리소스 탭, 트리 모드 또는 검색 기능을 사용하여 검색 결과 목록에서 호스트를 검색 및 선택합니다.

- 을 클릭하여 호스트 편집 창을 엽니다.

- 전원 관리 탭을 클릭합니다.

- 필드를 활성화하려면 전원 관리 활성 확인란을 선택합니다.

- Kdump 통합 확인란을 선택하여 커널 크래시 덤프 실행 시 호스트가 차단되지 않게 합니다.

중요

기존 호스트에서 Kdump 통합을 활성화할 때 kdump를 설정하기 위해 호스트를 다시 설치해야 합니다. 6.5.11절. “호스트 다시 설치”에서 참조하십시오. - 옵션으로 호스트의 전원 관리가 호스트 클러스터의 스케줄링 정책에 의해 제어되지 않게 하려면 전원 관리 정책 제어를 비활성화 확인란을 선택합니다.

- 플러스 () 버튼을 클릭하여 새 전원 관리 장치를 추가합니다. 펜스 에이전트 편집 창이 열립니다.

- 전원 관리 장치의 주소, 사용자 이름, 암호를 입력합니다.

- 드롭 다운 목록에서 전원 관리 장치 유형을 선택합니다.

참고

사용자 정의 전원 관리 장치 설정 방법에 대한 자세한 내용은 https://access.redhat.com/articles/1238743에서 참조하십시오. - 전원 관리 장치가 사용하는 SSH 포트 번호를 입력하여 호스트와 통신합니다.

- 전원 관리 장치의 블레이드를 구별하기 위해 사용하는 슬롯 번호를 입력합니다.

- 전원 관리 장치의 옵션을 입력합니다. 콤마로 구분된 'key=value' 항목을 사용합니다.

- 보안 확인란을 선택하여 호스트에 안전하게 연결하는 전원 관리 장치를 활성화합니다.

- 버튼을 클릭하여 설정이 올바른지 확인합니다. 작업 완료 후 Test Succeeded, Host Status is: on이 표시됩니다.

주의

전원 관리 매개 변수 (사용자 ID, 암호, 옵션 등)는 설정 시 Red Hat Virtualization Manager에 의해 테스트되며 그 후에는 수동으로 실행합니다. 잘못된 매개 변수에 대한 경고를 무시하거나 매개 변수가 전원 관리 하드웨어에서 변경되었지만 Red Hat Virtualization Manager에서는 변경되지 않은 경우 펜싱 실행을 실패할 수 있습니다. - 를 클릭하여 펜스 에이전트 편집 창을 닫습니다.

- 전원 관리 탭에서 옵션으로 고급 매개변수를 확장하고 위, 아래 버튼을 사용하여 Manager가 펜싱 프록시 용으로 호스트의 클러스터 및 dc (datacenter)를 검색할 순서를 지정합니다.

- 를 클릭합니다.

6.6.4. fence_kdump 고급 설정

- 활성화됨: kdump가 올바르게 설정되어 kdump 서비스가 실행되고 있습니다.

- 비활성화됨: kdump 서비스가 실행되고 있지 않습니다 (이 경우 kdump 통합이 올바르게 작동하지 않게 됩니다).

- 알 수 없음: kdump 상태를 보고하지 않는 이전 VDSM 버전을 사용하는 호스트의 경우에만 발생합니다.

engine-config를 사용하여 적절한 호스트 이름이나 IP 주소를 설정할 수 있습니다:

engine-config -s FenceKdumpDestinationAddress=A.B.C.D

- Manager에는 두 개의 NIC가 있습니다. 여기서 하나는 public-facing에 용이고 다른 하나는 fence_kdump 메세지의 지정 대상이 됩니다.

- 다른 IP 또는 포트에서 fence_kdump 수신기를 실행해야 합니다.

- fence_kdump 통지 메세지에 대해 사용자 정의 간격을 설정하여 가능한 패킷 손실을 방지합니다.

6.6.4.1. fence_kdump 수신기 설정

절차 6.18. 수동으로 fence_kdump 수신기 설정

/etc/ovirt-engine/ovirt-fence-kdump-listener.conf.d/에 새로운 파일을 (예:my-fence-kdump.conf) 생성합니다.- OPTION=value 구문으로 사용자 설정 항목을 입력하고 파일을 저장합니다.

중요

편집된 값은 6.6.4.2절. “Manager에서 fence_kdump 설정”에있는 fence_kdump 수신기 설정 옵션 표에서 설명되어 있듯이engine-config도 변경해야 합니다. - fence_kdump 수신기를 다시 시작합니다:

# service ovirt-fence-kdump-listener restart

표 6.6. fence_kdump 수신기 설정 옵션

| 변수 | 설명 | 기본값 | 알림 |

|---|---|---|---|

| LISTENER_ADDRESS | fence_kdump 메세지를 수신하기 위해 IP 주소를 정의합니다. | 0.0.0.0 | 이 매개 변수 값을 변경할 경우 engine-config에 있는 FenceKdumpDestinationAddress 값과 일치해야 합니다. |

| LISTENER_PORT | fence_kdump 메세지를 수신하기 위해 포트를 정의합니다. | 7410 | 이 매개 변수 값을 변경할 경우 engine-config에 있는 FenceKdumpDestinationPort 값과 일치해야 합니다. |

| HEARTBEAT_INTERVAL | 수신기의 하트비트 업데이트 간격을 초 단위로 정의합니다. | 30 | 매개 변수 값을 변경할 경우 engine-config에 있는 FenceKdumpListenerTimeout 값 보다 작은 절반 이하의 크기여야 합니다. |

| SESSION_SYNC_INTERVAL | 수신기의 호스트 메모리에서 kdumping 세션을 데이터베이스로 동기화하는 간격을 초 단위로 정의합니다. | 5 | 매개 변수 값을 변경할 경우 engine-config에 있는 KdumpStartedTimeout 값 보다 작은 절반 이하의 크기여야 합니다. |

| REOPEN_DB_CONNECTION_INTERVAL | 이전에 사용 불가능했던 데이터 베이스 연결을 다시 열기위한 간격을 초 단위로 정의합니다. | 30 | - |

| KDUMP_FINISHED_TIMEOUT | 호스트 kdump 흐름이 FINISHED로 표시된 후 kdump 실행 호스트에서 마지막으로 메세지를 수신할 때 까지 최대 시간 제한을 초 단위로 정의합니다. | 60 | 매개 변수 값을 변경할 경우 engine-config에 있는 FenceKdumpMessageInterval 값 보다 2 배 이상으로 큰 크기여야 합니다. |

6.6.4.2. Manager에서 fence_kdump 설정

# engine-config -g OPTION

절차 6.19. engine-config를 사용하여 수동으로 Kdump 설정

engine-config명령을 사용하여 kdump 설정을 편집합니다:# engine-config -s OPTION=value

중요

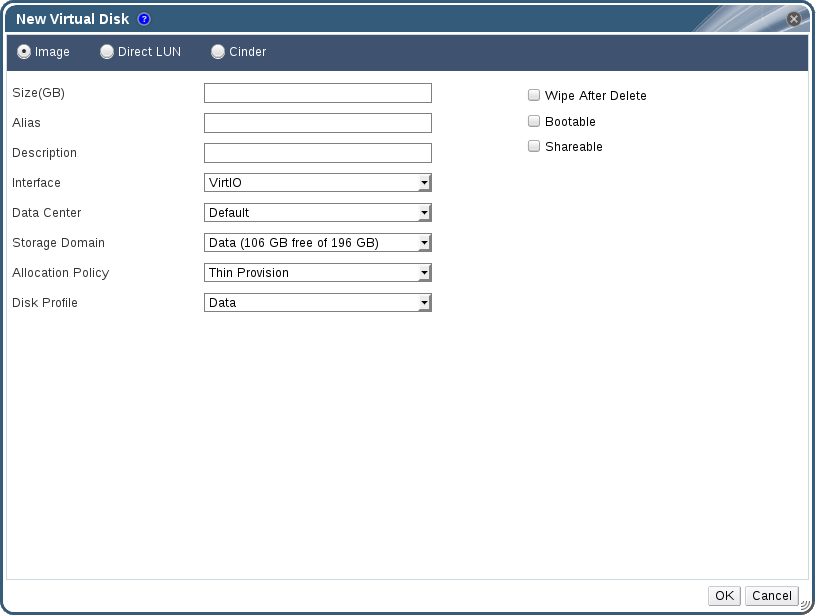

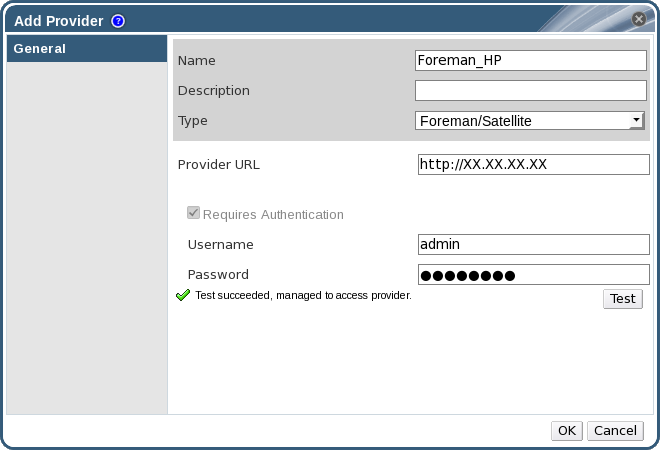

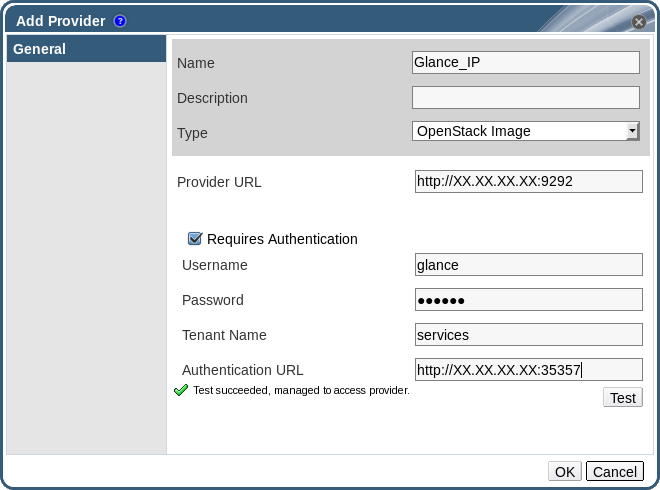

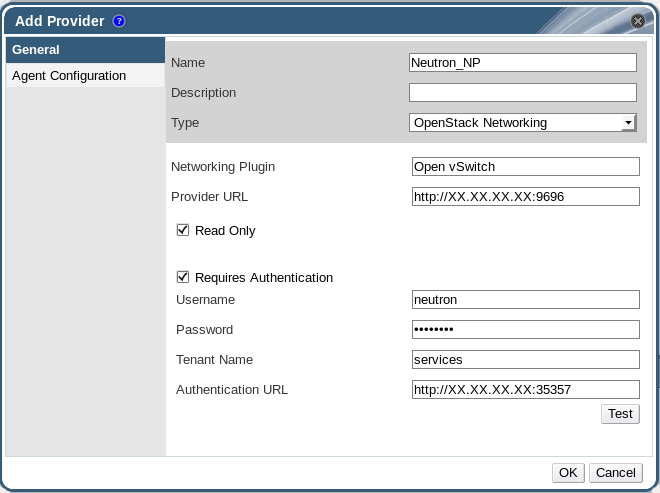

편집된 값은Kdump 설정 옵션표에 설명되어 있듯이 fence_kdump 수신기 설정 파일에도 변경해야 합니다. 자세한 내용은 6.6.4.1절. “fence_kdump 수신기 설정”에서 참조하십시오.ovirt-engine서비스를 다시 시작합니다:# service ovirt-engine restart