Red Hat Training

A Red Hat training course is available for RHEL 8

Implantação de diferentes tipos de servidores

Um guia para a implantação de diferentes tipos de servidores no Red Hat Enterprise Linux 8

Resumo

Tornando o código aberto mais inclusivo

A Red Hat tem o compromisso de substituir a linguagem problemática em nosso código, documentação e propriedades da web. Estamos começando com estes quatro termos: master, slave, blacklist e whitelist. Por causa da enormidade deste esforço, estas mudanças serão implementadas gradualmente ao longo de vários lançamentos futuros. Para mais detalhes, veja a mensagem de nosso CTO Chris Wright.

Fornecendo feedback sobre a documentação da Red Hat

Agradecemos sua contribuição em nossa documentação. Por favor, diga-nos como podemos melhorá-la. Para fazer isso:

Para comentários simples sobre passagens específicas:

- Certifique-se de que você está visualizando a documentação no formato Multi-page HTML. Além disso, certifique-se de ver o botão Feedback no canto superior direito do documento.

- Use o cursor do mouse para destacar a parte do texto que você deseja comentar.

- Clique no pop-up Add Feedback que aparece abaixo do texto destacado.

- Siga as instruções apresentadas.

Para enviar comentários mais complexos, crie um bilhete Bugzilla:

- Ir para o site da Bugzilla.

- Como Componente, use Documentation.

- Preencha o campo Description com sua sugestão de melhoria. Inclua um link para a(s) parte(s) relevante(s) da documentação.

- Clique em Submit Bug.

Capítulo 1. Configurando o servidor web Apache HTTP

1.1. Introdução ao servidor web Apache HTTP

Um web server é um serviço de rede que serve conteúdo para um cliente através da web. Isso normalmente significa páginas web, mas quaisquer outros documentos também podem ser ser servidos. Os servidores web também são conhecidos como servidores HTTP, pois utilizam o hypertext transport protocol (HTTP).

O Apache HTTP ServerA Apache Software Foundation, httpd, é um servidor web de código aberto desenvolvido pela Apache Software Foundation.

Se você estiver atualizando a partir de um lançamento anterior do Red Hat Enterprise Linux, você precisará atualizar a configuração do serviço httpd de acordo. Esta seção revisa alguns dos recursos recém-adicionados e o orienta através da atualização dos arquivos de configuração anteriores.

1.1.1. Mudanças notáveis no Servidor HTTP Apache

O Apache HTTP ServerEsta versão atualizada inclui várias características novas, mas mantém compatibilidade com a versão RHEL 7 no nível de configuração e Interface Binária de Aplicação (ABI) dos módulos externos.

As novas características incluem:

-

HTTP/2agora é fornecido pelo pacotemod_http2, que faz parte do módulohttpd. -

é suportada a ativação do soquete systemd. Consulte a página de manual

httpd.socket(8)para mais detalhes.

Múltiplos novos módulos foram adicionados:

-

mod_proxy_hcheck- um módulo de verificação de saúde por procuração -

mod_proxy_uwsgi- um proxy de interface Web Server Gateway (WSGI) -

mod_proxy_fdpass- fornece suporte para a passagem do soquete do cliente para outro processo -

mod_cache_socache- um cache HTTP usando, por exemplo, o backend memcache -

mod_md- um serviço de certificado do protocolo ACME SSL/TLS

-

Os seguintes módulos agora são carregados por padrão:

-

mod_request -

mod_macro -

mod_watchdog

-

-

Um novo subpacote,

httpd-filesystem, foi adicionado, que contém o layout básico do diretório para o Apache HTTP Server incluindo as permissões corretas para os diretórios. -

O suporte de serviço instantâneo,

httpd@.servicefoi introduzido. Veja a página de manualhttpd.servicepara mais informações.

-

Um novo

httpd-init.servicesubstitui o%post scriptpara criar um par de chaves autoassinadomod_ssl.

-

O provisionamento e renovação automatizada de certificados TLS usando o protocolo ACME (Automatic Certificate Management Environment) é agora suportado com o pacote

mod_md(para uso com provedores de certificados comoLet’s Encrypt). -

O Apache HTTP Server agora suporta o carregamento de certificados TLS e chaves privadas a partir de tokens de segurança de hardware diretamente dos módulos

PKCS#11. Como resultado, uma configuraçãomod_sslpode agora usarPKCS#11URLs para identificar a chave privada do TLS e, opcionalmente, o certificado TLS nas diretivasSSLCertificateKeyFileeSSLCertificateFile. Uma nova diretiva

ListenFreeno arquivo/etc/httpd/conf/httpd.confé agora suportada.De forma similar à diretiva

Listen,ListenFreefornece informações sobre endereços IP, portas ou endereços IP - e combinações de portas que o servidor ouve. Entretanto, comListenFree, a opção de soqueteIP_FREEBINDé ativada por padrão. Assim,httpdé permitido vincular a um endereço IP não local ou a um endereço IP que ainda não existe. Isto permite quehttpdescute em um socket sem exigir que a interface de rede subjacente ou o endereço IP dinâmico especificado esteja em alta no momento em quehttpdestiver tentando ligar-se a ele.Note que a diretiva

ListenFreeestá atualmente disponível apenas na RHEL 8.Para mais detalhes em

ListenFree, consulte a tabela a seguir:Tabela 1.1. Sintaxe, status e módulos da diretriz ListenFree

Sintaxe Status Módulos ListenFree [IP-address:]número de porta [protocolo]

MPM

evento, trabalhador, prefork, mpm_winnt, mpm_netware, mpmt_os2

Outras mudanças notáveis incluem:

Os seguintes módulos foram removidos:

-

mod_file_cache mod_nssUse

mod_sslcomo um substituto. Para detalhes sobre a migração demod_nss, veja Seção 1.10, “Exportar uma chave privada e certificados de um banco de dados NSS para utilizá-los na configuração de um servidor web Apache”.-

mod_perl

-

-

O tipo padrão do banco de dados de autenticação DBM utilizado pelo Apache HTTP Server no RHEL 8 foi alterado de

SDBMparadb5. -

O módulo

mod_wsgipara o Apache HTTP Server foi atualizado para Python 3. As aplicações WSGI agora são suportadas somente com Python 3, e devem ser migradas a partir de Python 2. O módulo multi-processamento (MPM) configurado por padrão com o Apache HTTP Server mudou de um modelo multi-processo, bifurcado (conhecido como

prefork) para um modelo multi-rosca de alto desempenho,event.Qualquer módulo de terceiros que não seja seguro para a rosca precisa ser substituído ou removido. Para alterar o MPM configurado, edite o arquivo

/etc/httpd/conf.modules.d/00-mpm.conf. Consulte a página de manualhttpd.service(8)para mais informações.- Os mínimos UID e GID permitidos aos usuários pelo suEXEC são agora 1000 e 500, respectivamente (anteriormente 100 e 100).

-

O arquivo

/etc/sysconfig/httpdnão é mais uma interface suportada para definir variáveis de ambiente para o serviçohttpd. A página de manualhttpd.service(8)foi adicionada para o serviço systemd. -

A interrupção do serviço

httpdagora usa uma "parada graciosa" por padrão. -

O módulo

mod_auth_kerbfoi substituído pelo módulomod_auth_gssapi.

1.1.2. Atualização da configuração

Para atualizar os arquivos de configuração do Apache HTTP Server usada no Red Hat Enterprise Linux 7, escolha uma das seguintes opções:

-

Se

/etc/sysconfig/httpdfor usado para definir variáveis de ambiente, crie um arquivo drop-in do sistema em seu lugar. - Se algum módulo de terceiros for utilizado, certifique-se de que seja compatível com um MPM rosqueado.

- Se for utilizado suexec, garantir que as identificações de usuário e grupo atendam aos novos mínimos.

Você pode verificar a configuração para possíveis erros usando o seguinte comando:

# apachectl configtest Syntax OK

1.2. Os arquivos de configuração do Apache

Quando o serviço httpd é iniciado, por padrão, ele lê a configuração de locais que estão listados em Tabela 1.2, “Os arquivos de configuração do serviço httpd”.

Tabela 1.2. Os arquivos de configuração do serviço httpd

| Caminho | Descrição |

|---|---|

|

| O arquivo principal de configuração. |

|

| Um diretório auxiliar para os arquivos de configuração que estão incluídos no arquivo de configuração principal. |

|

| Um diretório auxiliar para arquivos de configuração que carregam os módulos dinâmicos instalados no Red Hat Enterprise Linux. Na configuração default, estes arquivos de configuração são processados primeiro. |

Embora, a configuração padrão seja adequada para a maioria das situações, você pode usar também outras opções de configuração. Para que qualquer mudança tenha efeito, reinicie o servidor web primeiro. Veja Seção 1.3, “Gerenciando o serviço httpd” para mais informações sobre como reiniciar o serviço httpd.

Para verificar a configuração para possíveis erros, digite o seguinte em uma janela de comandos:

# apachectl configtest Syntax OK

Para facilitar a recuperação de erros, faça uma cópia do arquivo original antes de editá-lo.

1.3. Gerenciando o serviço httpd

Esta seção descreve a quente para iniciar, parar e reiniciar o serviço httpd.

Pré-requisitos

- O Servidor HTTP Apache está instalado.

Procedimento

Para iniciar o serviço

httpd, entre:# systemctl start httpd

Para interromper o serviço

httpd, entre:# systemctl stop httpd

Para reiniciar o serviço

httpd, entre:# systemctl restart httpd

1.4. Configuração de um Servidor HTTP Apache de uma única instância

Esta seção descreve como configurar um Servidor HTTP Apache de uma única instância para servir conteúdo HTML estático.

Siga o procedimento desta seção se o servidor web deve fornecer o mesmo conteúdo para todos os domínios associados com o servidor. Se você quiser fornecer conteúdo diferente para domínios diferentes, estabeleça hosts virtuais baseados em nomes. Para detalhes, veja Seção 1.5, “Configuração de hosts virtuais baseados no nome Apache”.

Procedimento

Instale o pacote

httpd:# yum instalar httpd

Abra a porta TCP

80no firewall local:# firewall-cmd --permanent --add-port=80/tcp # firewall-cmd --reload

Habilite e inicie o serviço

httpd:# systemctl enable --now httpd

Opcional: Adicionar arquivos HTML ao diretório

/var/www/html/.NotaAo adicionar conteúdo a

/var/www/html/, arquivos e diretórios devem ser legíveis pelo usuário, sob o qualhttpdé executado por padrão. O proprietário do conteúdo pode ser o usuárioroote o grupo de usuáriosroot, ou outro usuário ou grupo da escolha do administrador. Se o proprietário do conteúdo for o usuárioroote o grupo de usuáriosroot, os arquivos devem ser legíveis por outros usuários. O contexto SELinux para todos os arquivos e diretórios deve serhttpd_sys_content_t, que é aplicado por padrão a todo o conteúdo dentro do diretório/var/www.

Etapas de verificação

Conecte-se com um navegador da web para

http://server_IP_or_host_name/.Se o diretório

/var/www/html/estiver vazio ou não contiver um arquivoindex.htmlouindex.htm, o Apache exibe oRed Hat Enterprise Linux Test Page. Se/var/www/html/contém arquivos HTML com um nome diferente, você pode carregá-los inserindo a URL para esse arquivo, como por exemplohttp://server_IP_or_host_name/example.html.

Recursos adicionais

- Para maiores detalhes sobre como configurar o Apache e adaptar o serviço ao seu ambiente, consulte o manual do Apache. Para obter detalhes sobre a instalação do manual, consulte Seção 1.8, “Instalando o manual do Servidor HTTP Apache”.

-

Para detalhes sobre o uso ou ajuste do serviço

httpdsystemd, consulte a página de manualhttpd.service(8).

1.5. Configuração de hosts virtuais baseados no nome Apache

Os hosts virtuais baseados em nomes permitem que o Apache sirva diferentes conteúdos para diferentes domínios que resolvam para o endereço IP do servidor.

O procedimento nesta seção descreve a criação de um host virtual para o domínio example.com e example.net com diretórios raiz de documentos separados. Ambos os hosts virtuais servem conteúdo HTML estático.

Pré-requisitos

Os clientes e o servidor web resolvem o domínio

example.comeexample.netpara o endereço IP do servidor web.Observe que você deve adicionar manualmente estas entradas ao seu servidor DNS.

Procedimento

Instale o pacote

httpd:# yum instalar httpd

Edite o arquivo

/etc/httpd/conf/httpd.conf:Anexe a seguinte configuração de host virtual para o domínio

example.com:<VirtualHost *:80> DocumentRoot "/var/www/example.com/" ServerName example.com CustomLog /var/log/httpd/example.com_access.log combined ErrorLog /var/log/httpd/example.com_error.log </VirtualHost>Estas configurações configuram o seguinte:

-

Todas as configurações da diretiva

<VirtualHost *:80>são específicas para este host virtual. -

DocumentRootestabelece o caminho para o conteúdo da web do host virtual. ServerNamedefine os domínios para os quais este host virtual serve de conteúdo.Para definir vários domínios, adicione o parâmetro

ServerAliasà configuração e especifique os domínios adicionais separados com um espaço neste parâmetro.-

CustomLogdefine o caminho para o log de acesso do host virtual. ErrorLogdefine o caminho para o registro de erros do host virtual.NotaO Apache utiliza o primeiro host virtual encontrado na configuração também para solicitações que não correspondem a nenhum domínio definido nos parâmetros

ServerNameeServerAlias. Isto também inclui pedidos enviados para o endereço IP do servidor.

-

Todas as configurações da diretiva

Anexar uma configuração similar de host virtual para o domínio

example.net:<VirtualHost *:80> DocumentRoot "/var/www/example.net/" ServerName example.net CustomLog /var/log/httpd/example.net_access.log combined ErrorLog /var/log/httpd/example.net_error.log </VirtualHost>Criar as raízes dos documentos para ambos os anfitriões virtuais:

# mkdir /var/www/example.com/ # mkdir /var/www/example.net/

Se você definir caminhos nos parâmetros

DocumentRootque não estão dentro de/var/www/, defina o contextohttpd_sys_content_tem ambas as raízes do documento:# semanage fcontext -a -t httpd_sys_content_t "/srv/example.com(/.*)?" # restorecon -Rv /srv/example.com/ # semanage fcontext -a -t httpd_sys_content_t "/srv/example.net(/.\*)?" # restorecon -Rv /srv/example.net/

Estes comandos definem o contexto

httpd_sys_content_tno diretório/srv/example.com/e/srv/example.net/.Note que você deve instalar o pacote

policycoreutils-python-utilspara executar o comandorestorecon.Abra a porta

80no firewall local:# firewall-cmd --permanent --add-port=80/tcp # firewall-cmd --reload

Habilite e inicie o serviço

httpd:# systemctl enable --now httpd

Etapas de verificação

Criar um arquivo de exemplo diferente em cada raiz de documento do host virtual:

# echo "vHost example.com" > /var/www/example.com/index.html # echo "vHost example.net" > /var/www/example.net/index.html

-

Use um navegador e conecte-se a

http://example.com. O servidor web mostra o arquivo de exemplo do host virtualexample.com. -

Use um navegador e conecte-se a

http://example.net. O servidor web mostra o arquivo de exemplo do host virtualexample.net.

Recursos adicionais

-

Para mais detalhes sobre a configuração dos hosts virtuais Apache, consulte a documentação

Virtual Hostsno manual Apache. Para detalhes sobre a instalação do manual, veja Seção 1.8, “Instalando o manual do Servidor HTTP Apache”.

1.6. Configurando a criptografia TLS em um servidor Apache HTTP

Por padrão, o Apache fornece conteúdo aos clientes usando uma conexão HTTP não criptografada. Esta seção descreve como habilitar a criptografia TLS e configurar as configurações freqüentemente usadas relacionadas à criptografia em um Servidor HTTP Apache.

Pré-requisitos

- O Servidor HTTP Apache está instalado e funcionando.

1.6.1. Adicionando criptografia TLS a um Servidor HTTP Apache

Esta seção descreve como ativar a criptografia TLS em um Servidor HTTP Apache para o domínio example.com.

Pré-requisitos

- O Servidor HTTP Apache está instalado e funcionando.

A chave privada é armazenada no arquivo

/etc/pki/tls/private/example.com.key.Para detalhes sobre a criação de uma chave privada e pedido de assinatura de certificado (CSR), bem como sobre como solicitar um certificado a uma autoridade certificadora (CA), consulte a documentação de sua CA. Alternativamente, se sua CA suporta o protocolo ACME, você pode usar o módulo

mod_mdpara automatizar a recuperação e o provisionamento de certificados TLS.-

O certificado do TLS é armazenado no arquivo

/etc/pki/tls/private/example.com.crt. Se você usar um caminho diferente, adapte as etapas correspondentes do procedimento. -

O certificado da CA é armazenado no arquivo

/etc/pki/tls/private/ca.crt. Se você usar um caminho diferente, adapte as etapas correspondentes do procedimento. - Os clientes e o servidor web resolvem o nome do anfitrião do servidor para o endereço IP do servidor web.

Procedimento

Instale o pacote

mod_ssl:# dnf install mod_ssl

Edite o arquivo

/etc/httpd/conf.d/ssl.confe adicione as seguintes configurações à diretiva<VirtualHost _default_:443>:Defina o nome do servidor:

ServerName example.comImportanteO nome do servidor deve corresponder à entrada definida no campo

Common Namedo certificado.Opcional: Se o certificado contiver nomes de host adicionais no campo

Subject Alt Names(SAN), você pode configurarmod_sslpara fornecer criptografia TLS também para esses nomes de host. Para configurar isto, adicione o parâmetroServerAliasescom os nomes correspondentes:ServerAlias www.example.com server.example.com

Defina os caminhos para a chave privada, o certificado do servidor e o certificado da CA:

SSLCertificateKeyFile "/etc/pki/tls/private/example.com.key" SSLCertificateFile "/etc/pki/tls/certs/example.com.crt" SSLCACertificateFile "/etc/pki/tls/certs/ca.crt"

Por razões de segurança, configure que somente o usuário

rootpossa acessar o arquivo de chave privada:# chown root:root /etc/pki/tls/private/example.com.key # chmod 600 /etc/pki/tls/private/example.com.key

AtençãoSe a chave privada foi acessada por usuários não autorizados, revogar o certificado, criar uma nova chave privada e solicitar um novo certificado. Caso contrário, a conexão TLS não é mais segura.

Abra a porta

443no firewall local:# firewall-cmd --permanent --add-port=443 # firewall-cmd --reload

Reinicie o serviço

httpd:# systemctl restart httpd

NotaSe você protegeu o arquivo de chave privada com uma senha, você deve digitar esta senha toda vez que o serviço

httpdfor iniciado.

Etapas de verificação

-

Use um navegador e conecte-se a

https://example.com.

Recursos adicionais

-

Para mais detalhes sobre a configuração do TLS, consulte a documentação

SSL/TLS Encryptionno manual do Apache. Para detalhes sobre a instalação do manual, veja Seção 1.8, “Instalando o manual do Servidor HTTP Apache”.

1.6.2. Configuração das versões do protocolo TLS suportadas em um Servidor HTTP Apache

Por padrão, o Servidor HTTP Apache no RHEL 8 utiliza a política de criptografia de todo o sistema que define valores seguros padrão, que também são compatíveis com navegadores recentes. Por exemplo, a política DEFAULT define que somente as versões do protocolo TLSv1.2 e TLSv1.3 são habilitadas no Apache.

Esta seção descreve como configurar manualmente quais versões do protocolo TLS seu Servidor HTTP Apache suporta. Siga o procedimento se seu ambiente exigir que somente versões específicas do protocolo TLS sejam habilitadas, por exemplo:

-

Se seu ambiente exige que os clientes também possam utilizar o fraco protocolo

TLS1(TLSv1.0) ouTLS1.1. -

Se você quiser configurar que o Apache suporta apenas o protocolo

TLSv1.2ouTLSv1.3.

Pré-requisitos

- A criptografia TLS está habilitada no servidor, conforme descrito em Seção 1.6.1, “Adicionando criptografia TLS a um Servidor HTTP Apache”.

Procedimento

Edite o arquivo

/etc/httpd/conf/httpd.conf, e adicione a seguinte configuração à diretiva<VirtualHost>para a qual você deseja definir a versão do protocolo TLS. Por exemplo, para habilitar somente o protocoloTLSv1.3:SSLProtocol -Todos os TLSv1.3

Reinicie o serviço

httpd:# systemctl restart httpd

Etapas de verificação

Use o seguinte comando para verificar se o servidor suporta

TLSv1.3:# openssl s_client -connect example.com:443 -tls1_3Use o seguinte comando para verificar se o servidor não suporta

TLSv1.2:# openssl s_client -connect example.com:443 -tls1_2Se o servidor não suportar o protocolo, o comando retorna um erro:

140111600609088:error:1409442E:SSL routines:ssl3_read_bytes:tlsv1 alert protocol version:ssl/record/rec_layer_s3.c:1543:SSL alert number 70

- Opcional: Repetir o comando para outras versões do protocolo TLS.

Recursos adicionais

-

Para mais detalhes sobre a política de criptografia do sistema, consulte a página de manual

update-crypto-policies(8)e Utilizando políticas criptográficas de todo o sistema. -

Para mais detalhes sobre o parâmetro

SSLProtocol, consulte a documentaçãomod_sslno manual do Apache. Para obter detalhes sobre a instalação do manual, consulte Seção 1.8, “Instalando o manual do Servidor HTTP Apache”.

1.6.3. Configurando as cifras suportadas em um Servidor HTTP Apache

Por padrão, o Servidor HTTP Apache no RHEL 8 utiliza a política de criptografia de todo o sistema que define valores seguros padrão, que também são compatíveis com navegadores recentes. Para a lista de cifras que a criptografia em todo o sistema permite, veja o arquivo /etc/crypto-policies/back-ends/openssl.config.

Esta seção descreve como configurar manualmente quais cifras seu Servidor HTTP Apache suporta. Siga o procedimento se seu ambiente exigir cifras específicas.

Pré-requisitos

- A criptografia TLS está habilitada no servidor, conforme descrito em Seção 1.6.1, “Adicionando criptografia TLS a um Servidor HTTP Apache”.

Procedimento

Edite o arquivo

/etc/httpd/conf/httpd.conf, e adicione o parâmetroSSLCipherSuiteà diretiva<VirtualHost>para a qual você deseja definir as cifras TLS:SSLCipherSuite "EECDH AESGCM:EDH AESGCM:AES256 EECDH:AES256 EDH:!SHA1:!SHA256"

Este exemplo permite apenas as cifras

EECDH AESGCM,EDH AESGCM,AES256 EECDHeAES256 EDHe desativa todas as cifras que utilizam o código de autenticação de mensagens (MAC)SHA1eSHA256.Reinicie o serviço

httpd:# systemctl restart httpd

Etapas de verificação

Para exibir a lista de cifras que o Servidor HTTP Apache suporta:

Instale o pacote

nmap:nmap # yum instalar nmap

Use o utilitário

nmappara exibir as cifras suportadas:# nmap --script ssl-enum-ciphers -p 443 example.com ... PORT STATE SERVICE 443/tcp open https | ssl-enum-ciphers: | TLSv1.2: | ciphers: | TLS_ECDHE_RSA_WITH_AES_256_GCM_SHA384 (ecdh_x25519) - A | TLS_DHE_RSA_WITH_AES_256_GCM_SHA384 (dh 2048) - A | TLS_ECDHE_RSA_WITH_CHACHA20_POLY1305_SHA256 (ecdh_x25519) - A ...

Recursos adicionais

-

Para mais detalhes sobre a política de criptografia do sistema, consulte a página de manual

update-crypto-policies(8)e Utilizando políticas criptográficas de todo o sistema. -

Para mais detalhes sobre o parâmetro

SSLCipherSuite, consulte a documentaçãomod_sslno manual do Apache. Para obter detalhes sobre a instalação do manual, consulte Seção 1.8, “Instalando o manual do Servidor HTTP Apache”.

1.7. Configuração da autenticação do certificado do cliente TLS

A autenticação do certificado do cliente permite aos administradores permitir que somente usuários que se autenticam usando um certificado acessem recursos no servidor web. Esta seção descreve como configurar a autenticação de certificado de cliente para o diretório /var/www/html/Example/.

Se o Servidor HTTP Apache utiliza o protocolo TLS 1.3, certos clientes requerem configuração adicional. Por exemplo, no Firefox, defina o parâmetro security.tls.enable_post_handshake_auth no menu about:config para true. Para mais detalhes, veja Transport Layer Security versão 1.3 no Red Hat Enterprise Linux 8.

Pré-requisitos

- A criptografia TLS está habilitada no servidor, conforme descrito em Seção 1.6.1, “Adicionando criptografia TLS a um Servidor HTTP Apache”.

Procedimento

Edite o arquivo

/etc/httpd/conf/httpd.confe adicione as seguintes configurações à diretiva<VirtualHost>para a qual você deseja configurar a autenticação do cliente:<Directory "/var/www/html/Example/"> SSLVerifyClient require </Directory>

A configuração

SSLVerifyClient requiredefine que o servidor deve validar com sucesso o certificado do cliente antes que o cliente possa acessar o conteúdo no diretório/var/www/html/Example/.Reinicie o serviço

httpd:# systemctl restart httpd

Etapas de verificação

Use o utilitário

curlpara acessar a URLhttps://example.com/Example/sem autenticação do cliente:$ curl https://example.com/Example/ curl: (56) OpenSSL SSL_read: error:1409445C:SSL routines:ssl3_read_bytes:tlsv13 alert certificate required, errno 0O erro indica que o servidor web requer uma autenticação de certificado de cliente.

Passe a chave privada e o certificado do cliente, assim como o certificado da CA para

curlpara acessar a mesma URL com a autenticação do cliente:$ enrolado --cacert ca.crt --key client.key --cert client.crt https://example.com/Example/

Se a solicitação for bem sucedida,

curlexibe o arquivoindex.htmlarmazenado no diretório/var/www/html/Example/.

Recursos adicionais

-

Para mais detalhes sobre autenticação de clientes, consulte a documentação

mod_ssl Configuration How-Tono manual Apache. Para detalhes sobre a instalação do manual, veja Seção 1.8, “Instalando o manual do Servidor HTTP Apache”.

1.8. Instalando o manual do Servidor HTTP Apache

Esta seção descreve como instalar o manual do Servidor HTTP Apache. Este manual fornece uma documentação detalhada de, por exemplo:

- Parâmetros de configuração e diretrizes

- Sintonia de desempenho

- Configurações de autenticação

- Módulos

- Caching de conteúdo

- Dicas de segurança

- Configurando a criptografia TLS

Após instalar o manual, você pode exibi-lo usando um navegador web.

Pré-requisitos

- O Servidor HTTP Apache está instalado e funcionando.

Procedimento

Instale o pacote

httpd-manual:# yum instalar httpd-manual

Opcional: Por padrão, todos os clientes conectados ao Servidor HTTP Apache podem exibir o manual. Para restringir o acesso a uma faixa IP específica, como a sub-rede

192.0.2.0/24, edite o arquivo/etc/httpd/conf.d/manual.confe adicione a configuraçãoRequire ip 192.0.2.0/24à diretiva<Directory "/usr/share/httpd/manual">:<Directory "/usr/share/httpd/manual"> ... Require ip 192.0.2.0/24 ... </Directory>Reinicie o serviço

httpd:# systemctl restart httpd

Etapas de verificação

-

Para exibir o manual do Servidor HTTP Apache, conecte-se com um navegador da web para

http://host_name_or_IP_address/manual/

1.9. Trabalhando com módulos

Sendo uma aplicação modular, o serviço httpd é distribuído juntamente com um número de Dynamic Shared Objects (DSOs), que pode ser carregado ou descarregado dinamicamente em tempo de execução, conforme necessário. Estes módulos estão localizados no diretório /usr/lib64/httpd/modules/.

1.9.1. Carregamento de um módulo

Para carregar um determinado módulo DSO, use a diretiva LoadModule. Observe que os módulos fornecidos por um pacote separado freqüentemente têm seu próprio arquivo de configuração no diretório /etc/httpd/conf.modules.d/.

Exemplo 1.1. Carregando o mod_ssl DSO

LoadModule ssl_module ssl_module modules/mod_ssl.so

Depois de carregar o módulo, reinicie o servidor web para recarregar a configuração. Veja Seção 1.3, “Gerenciando o serviço httpd” para mais informações sobre como reiniciar o serviço httpd.

1.9.2. Escrever um módulo

Para criar um novo módulo DSO, certifique-se de ter o pacote httpd-devel instalado. Para fazer isso, digite o seguinte comando como root:

# yum instalar httpd-devel

Este pacote contém os arquivos de inclusão, os arquivos de cabeçalho, e os arquivos de APache eXtenSion (apxs) utilidade necessária para a compilação de um módulo.

Uma vez escrito, você pode construir o módulo com o seguinte comando:

# Apxs -i -a -c_nome_do_módulo.c

Se a construção foi bem sucedida, você deve ser capaz de carregar o módulo da mesma forma que qualquer outro módulo que é distribuído com o Apache HTTP Server.

1.10. Exportar uma chave privada e certificados de um banco de dados NSS para utilizá-los na configuração de um servidor web Apache

A RHEL 8 não fornece mais o módulo mod_nss para o servidor web Apache, e a Red Hat recomenda o uso do módulo mod_ssl. Se você armazenar sua chave privada e certificados em um banco de dados de Serviços de Segurança de Rede (NSS), por exemplo, porque você migrou o servidor web do RHEL 7 para o RHEL 8, siga este procedimento para extrair a chave e os certificados no formato Privacy Enhanced Mail (PEM). Você pode então utilizar os arquivos na configuração mod_ssl, conforme descrito em Seção 1.6, “Configurando a criptografia TLS em um servidor Apache HTTP”.

Este procedimento assume que o banco de dados do NSS é armazenado em /etc/httpd/alias/ e que você armazena a chave privada exportada e os certificados no diretório /etc/pki/tls/.

Pré-requisitos

- A chave privada, o certificado e o certificado da autoridade certificadora (CA) são armazenados em um banco de dados do NSS.

Procedimento

Liste os certificados no banco de dados do NSS:

#

certutil -d /etc/httpd/alias/ -LCertificate Nickname Trust Attributes SSL,S/MIME,JAR/XPI Example CA C,, Example Server Certificate u,u,uVocê precisa dos apelidos dos certificados nas próximas etapas.

Para extrair a chave privada, você deve exportar temporariamente a chave para um arquivo PKCS #12:

Use o apelido do certificado associado à chave privada, para exportar a chave para um arquivo PKCS #12:

#

pk12util -o /etc/pki/tls/private/export.p12 -d /etc/httpd/alias/ -n "Example Server Certificate"Enter password for PKCS12 file: password Re-enter password: password pk12util: PKCS12 EXPORT SUCCESSFULObserve que você deve definir uma senha no arquivo PKCS #12. Você precisa desta senha na próxima etapa.

Exportar a chave privada do arquivo PKCS #12:

#

openssl pkcs12 -in /etc/pki/tls/private/export.p12 -out /etc/pki/tls/private/server.key -nocerts -nodesEnter Import Password: password MAC verified OKApagar o arquivo temporário PKCS #12:

#

rm /etc/pki/tls/private/export.p12

Defina as permissões em

/etc/pki/tls/private/server.keypara garantir que somente o usuáriorootpossa acessar este arquivo:#

chown root:root /etc/pki/tls/private/server.key#chmod 0600 /etc/pki/tls/private/server.keyUse o apelido do certificado do servidor no banco de dados do NSS para exportar o certificado CA:

#

certutil -d /etc/httpd/alias/ -L -n "Example Server Certificate" -a -o /etc/pki/tls/certs/server.crtDefina as permissões em

/etc/pki/tls/certs/server.crtpara garantir que somente o usuáriorootpossa acessar este arquivo:#

chown root:root /etc/pki/tls/certs/server.crt#chmod 0600 /etc/pki/tls/certs/server.crtUse o apelido do certificado CA no banco de dados do NSS para exportar o certificado CA:

#

certutil -d /etc/httpd/alias/ -L -n "Example CA" -a -o /etc/pki/tls/certs/ca.crtSiga Seção 1.6, “Configurando a criptografia TLS em um servidor Apache HTTP” para configurar o servidor web Apache, e:

-

Ajustar o parâmetro

SSLCertificateKeyFilepara/etc/pki/tls/private/server.key. -

Ajustar o parâmetro

SSLCertificateFilepara/etc/pki/tls/certs/server.crt. -

Ajustar o parâmetro

SSLCACertificateFilepara/etc/pki/tls/certs/ca.crt.

-

Ajustar o parâmetro

Recursos adicionais

-

A página do homem

certutil(1) -

A página do homem

pk12util(1) -

A página do homem

pkcs12(1ssl)

1.11. Recursos adicionais

-

httpd(8)- A página do manual do serviçohttpdcontendo a lista completa de suas opções de linha de comando. -

httpd.service(8)- A página do manual do arquivo da unidadehttpd.service, descrevendo como personalizar e melhorar o serviço. -

httpd.conf(5)- A página de manual de configuraçãohttpd, descrevendo a estrutura e localização dos arquivos de configuraçãohttpd. -

apachectl(8)- A página do manual para o Apache HTTP Server Interface de controle.

Capítulo 2. Instalação e configuração do NGINX

NGINX é um servidor modular e de alto desempenho que você pode usar, por exemplo, como um:

- Servidor Web

- Proxy reverso

- Balanceador de carga

Esta seção descreve como fazer o NGINX nestes cenários.

2.1. Instalando e preparando o NGINX

A Red Hat usa os fluxos de aplicação para fornecer diferentes versões do NGINX. Esta seção descreve como fazê-lo:

- Selecione um fluxo e instale o NGINX

- Abrir as portas necessárias no firewall

-

Habilitar e iniciar o serviço

nginx

Usando a configuração padrão, NGINX roda como um servidor web na porta 80 e fornece conteúdo do diretório /usr/share/nginx/html/.

Pré-requisitos

- O RHEL 8 está instalado.

- O anfitrião está inscrito no Portal do Cliente da Red Hat.

-

O serviço

firewalldestá habilitado e foi iniciado.

Procedimento

Mostrar os fluxos de módulos NGINX disponíveis:

#

yum module list nginxRed Hat Enterprise Linux 8 for x86_64 - AppStream (RPMs) Name Stream Profiles Summary nginx 1.14 [d] common [d] nginx webserver nginx 1.16 common [d] nginx webserver ... Hint: [d]efault, [e]nabled, [x]disabled, [i]nstalledSe você quiser instalar um fluxo diferente do padrão, selecione o fluxo:

#

yum module enable nginx:stream_versionInstale o pacote

nginx:#

yum install nginxAbra as portas nas quais a NGINX deve fornecer seu serviço no firewall. Por exemplo, para abrir as portas padrão para HTTP (porta 80) e HTTPS (porta 443) em

firewalld, entre:#

firewall-cmd --permanent --add-port={80/tcp,443/tcp}#firewall-cmd --reloadHabilitar o serviço

nginxpara iniciar automaticamente quando o sistema inicializar:#

systemctl enable nginxOpcionalmente, inicie o serviço

nginx:#

systemctl start nginxSe você não quiser usar a configuração padrão, pule esta etapa e configure o NGINX de acordo antes de iniciar o serviço.

Etapas de verificação

Use o utilitário

yumpara verificar se o pacotenginxestá instalado:#

yum list installed nginxInstalled Packages nginx.x86_64 1:1.14.1-9.module+el8.0.0+4108+af250afe @rhel-8-for-x86_64-appstream-rpmsAssegurar que os portos nos quais a NGINX deve prestar seu serviço sejam abertos na firewalld:

#

firewall-cmd --list-ports80/tcp 443/tcpVerifique se o serviço

nginxestá habilitado:#

systemctl is-enabled nginxenabled

Recursos adicionais

- Para obter detalhes sobre o Gerenciador de Assinaturas, consulte o guia de Uso e Configuração do Gerenciador de Assinaturas.

- Para mais detalhes sobre Fluxos de Aplicação, módulos e instalação de pacotes, consulte o guia Instalação, gerenciamento e remoção de componentes de espaço do usuário.

- Para obter detalhes sobre a configuração de firewalls, consulte o guia Securing networks guide.

2.2. Configuração do NGINX como um servidor web que fornece diferentes conteúdos para diferentes domínios

Por padrão, NGINX atua como um servidor web que fornece o mesmo conteúdo aos clientes para todos os nomes de domínio associados com os endereços IP do servidor. Este procedimento explica como configurar o NGINX:

-

Para atender aos pedidos ao domínio

example.comcom conteúdo do diretório/var/www/example.com/ -

Para atender aos pedidos ao domínio

example.netcom conteúdo do diretório/var/www/example.net/ -

Para atender todas as outras solicitações, por exemplo, para o endereço IP do servidor ou para outros domínios associados com o endereço IP do servidor, com conteúdo do diretório

/usr/share/nginx/html/

Pré-requisitos

- O NGINX é instalado como descrito em Seção 2.1, “Instalando e preparando o NGINX”.

Os clientes e o servidor web resolvem o domínio

example.comeexample.netpara o endereço IP do servidor web.Observe que você deve adicionar manualmente estas entradas ao seu servidor DNS.

Procedimento

Edite o arquivo

/etc/nginx/nginx.conf:Por padrão, o arquivo

/etc/nginx/nginx.confjá contém uma configuração "catch-all". Se você eliminou esta parte da configuração, readicione o seguinte blocoserverao blocohttpno arquivo/etc/nginx/nginx.conf:server { listen 80 default_server; listen [::]:80 default_server; server_name _; root /usr/share/nginx/html; }Estas configurações configuram o seguinte:

-

A diretiva

listendefine o endereço IP e as portas que o serviço escuta. Neste caso, NGINX escuta na porta80tanto em todos os endereços IPv4 como IPv6. O parâmetrodefault_serverindica que o NGINX usa este blocoservercomo padrão para solicitações correspondentes aos endereços IP e portas. -

O parâmetro

server_namedefine os nomes dos anfitriões pelos quais este blocoserveré responsável. O parâmetroserver_namepara_configura o NGINX para aceitar qualquer nome de host para este blocoserver. -

A diretiva

rootestabelece o caminho para o conteúdo da web para este blocoserver.

-

A diretiva

Acrescentar um bloco similar

serverpara o domínioexample.comao blocohttp:server { server_name example.com; root /var/www/example.com/; access_log /var/log/nginx/example.com/access.log; error_log /var/log/nginx/example.com/error.log; }-

A diretiva

access_logdefine um arquivo de log de acesso separado para este domínio. -

A diretiva

error_logdefine um arquivo de registro de erros separado para este domínio.

-

A diretiva

Acrescentar um bloco similar

serverpara o domínioexample.netao blocohttp:server { server_name example.net; root /var/www/example.net/; access_log /var/log/nginx/example.net/access.log; error_log /var/log/nginx/example.net/error.log; }

Criar os diretórios raiz para ambos os domínios:

#

mkdir -p /var/www/example.com/#mkdir -p /var/www/example.net/Configurar o contexto

httpd_sys_content_tem ambos os diretórios raiz:#

semanage fcontext -a -t httpd_sys_content_t "/var/www/example.com(/.*)?"#restorecon -Rv /var/www/example.com/#semanage fcontext -a -t httpd_sys_content_t "/var/www/example.net(/.\*)?"#restorecon -Rv /var/www/example.net/Estes comandos definem o contexto

httpd_sys_content_tnos diretórios/var/www/example.com/e/var/www/example.net/.Note que você deve instalar o pacote

policycoreutils-python-utilspara executar os comandosrestorecon.Criar os diretórios de log para os dois domínios:

#

mkdir /var/log/nginx/example.com/#mkdir /var/log/nginx/example.net/Reinicie o serviço

nginx:#

systemctl restart nginx

Etapas de verificação

Criar um arquivo de exemplo diferente em cada raiz de documento do host virtual:

#

echo "Content for example.com" > /var/www/example.com/index.html#echo "Content for example.net" > /var/www/example.net/index.html#echo "Catch All content" > /usr/share/nginx/html/index.html-

Use um navegador e conecte-se a

http://example.com. O servidor web mostra o conteúdo do exemplo do arquivo/var/www/example.com/index.html. -

Use um navegador e conecte-se a

http://example.net. O servidor web mostra o conteúdo do exemplo do arquivo/var/www/example.net/index.html. -

Use um navegador e conecte-se a

http://IP_address_of_the_server. O servidor web mostra o conteúdo do exemplo do arquivo/usr/share/nginx/html/index.html.

2.3. Adicionando a criptografia TLS a um servidor web NGINX

Esta seção descreve como habilitar a criptografia TLS em um servidor web NGINX para o domínio example.com.

Pré-requisitos

- O NGINX é instalado como descrito em Seção 2.1, “Instalando e preparando o NGINX”.

A chave privada é armazenada no arquivo

/etc/pki/tls/private/example.com.key.Para detalhes sobre a criação de uma chave privada e pedido de assinatura de certificado (CSR), bem como sobre como solicitar um certificado de uma autoridade certificadora (CA), consulte a documentação de sua CA.

-

O certificado do TLS é armazenado no arquivo

/etc/pki/tls/certs/example.com.crt. Se você usar um caminho diferente, adapte as etapas correspondentes do procedimento. - O certificado CA foi anexado ao arquivo do certificado TLS do servidor.

- Os clientes e o servidor web resolvem o nome do anfitrião do servidor para o endereço IP do servidor web.

-

A porta

443está aberta no firewall local.

Procedimento

Edite o arquivo

/etc/nginx/nginx.confe adicione o seguinte blocoserverao blocohttpna configuração:server { listen 443 ssl; server_name example.com; root /usr/share/nginx/html; ssl_certificate /etc/pki/tls/certs/example.com.crt; ssl_certificate_key /etc/pki/tls/private/example.com.key; }Por razões de segurança, configure que somente o usuário

rootpossa acessar o arquivo de chave privada:#

chown root:root /etc/pki/tls/private/example.com.key#chmod 600 /etc/pki/tls/private/example.com.keyAtençãoSe a chave privada foi acessada por usuários não autorizados, revogar o certificado, criar uma nova chave privada e solicitar um novo certificado. Caso contrário, a conexão TLS não é mais segura.

Reinicie o serviço

nginx:#

systemctl restart nginx

Etapas de verificação

-

Use um navegador e conecte-se a

https://example.com

2.4. Configuração do NGINX como proxy reverso para o tráfego HTTP

Você pode configurar o servidor web NGINX para atuar como um proxy reverso para o tráfego HTTP. Por exemplo, você pode usar esta funcionalidade para encaminhar solicitações para um subdiretório específico em um servidor remoto. Do ponto de vista do cliente, o cliente carrega o conteúdo a partir do host ao qual acessa. Entretanto, NGINX carrega o conteúdo real do servidor remoto e o encaminha para o cliente.

Este procedimento explica como encaminhar o tráfego para o diretório /example no servidor web para a URL https://example.com.

Pré-requisitos

- O NGINX é instalado como descrito em Seção 2.1, “Instalando e preparando o NGINX”.

- Opcional: A criptografia TLS é habilitada no proxy reverso.

Procedimento

Edite o arquivo

/etc/nginx/nginx.confe adicione as seguintes configurações ao blocoserverque deve fornecer o proxy reverso:location /example { proxy_pass https://example.com; }O bloco

locationdefine que a NGINX passa todas as solicitações no diretório/exampleparahttps://example.com.Defina o parâmetro booleano

httpd_can_network_connectSELinux para1para configurar que o SELinux permite que o NGINX encaminhe o tráfego:#

setsebool -P httpd_can_network_connect 1Reinicie o serviço

nginx:#

systemctl restart nginx

Etapas de verificação

-

Use um navegador e conecte-se a

http://host_name/examplee o conteúdo dehttps://example.comé mostrado.

2.5. Configurando o NGINX como um balanceador de carga HTTP

Você pode usar o recurso de proxy reverso NGINX para balancear o tráfego de carga. Este procedimento descreve como configurar o NGINX como um balanceador de carga HTTP que envia solicitações para diferentes servidores, com base em qual deles tem o menor número de conexões ativas. Se os dois servidores não estiverem disponíveis, o procedimento também define um terceiro host por razões de fallback.

Pré-requisitos

- O NGINX é instalado como descrito em Seção 2.1, “Instalando e preparando o NGINX”.

Procedimento

Edite o arquivo

/etc/nginx/nginx.confe adicione as seguintes configurações:http { upstream backend { least_conn; server server1.example.com; server server2.example.com; server server3.example.com backup; } server { location / { proxy_pass http://backend; } } }A diretiva

least_conndo grupo anfitriãobackenddefine que a NGINX envia solicitações paraserver1.example.comouserver2.example.com, dependendo de qual anfitrião tem o menor número de conexões ativas. NGINX usaserver3.example.comapenas como backup caso os outros dois hospedeiros não estejam disponíveis.Com a diretiva

proxy_passdefinida parahttp://backend, NGINX atua como um proxy reverso e usa o grupo anfitriãobackendpara distribuir solicitações com base nas configurações deste grupo.Em vez do método de balanceamento de carga

least_conn, você pode especificar:- Nenhum método para usar round robin e distribuir os pedidos uniformemente entre os servidores.

-

ip_hashpara enviar solicitações de um endereço de cliente para o mesmo servidor com base em um hash calculado a partir dos três primeiros octetos do endereço IPv4 ou de todo o endereço IPv6 do cliente. -

hashpara determinar o servidor com base em uma chave definida pelo usuário, que pode ser uma string, uma variável ou uma combinação de ambas. O parâmetroconsistentconfigura que o NGINX distribui as solicitações por todos os servidores com base no valor da chave definida pelo usuário. -

randompara enviar solicitações para um servidor selecionado aleatoriamente.

Reinicie o serviço

nginx:#

systemctl restart nginx

2.6. Recursos adicionais

- Para a documentação oficial do NGINX, ver https://nginx.org/en/docs/. Note que a Red Hat não mantém esta documentação e que ela pode não funcionar com a versão do NGINX que você instalou.

Capítulo 3. Usando Samba como um servidor

O Samba implementa o protocolo Server Message Block (SMB) no Red Hat Enterprise Linux. O protocolo SMB é usado para acessar recursos em um servidor, tais como compartilhamento de arquivos e impressoras compartilhadas. Além disso, o Samba implementa o protocolo de Chamada de Procedimento Remoto de Ambiente de Computação Distribuída (DCE RPC) usado pelo Microsoft Windows.

Você pode administrar o Samba como:

- Um membro do Active Directory (AD) ou do domínio NT4

- Um servidor autônomo

Um controlador de domínio primário NT4 (PDC) ou controlador de domínio de backup (BDC)

NotaA Red Hat suporta os modos PDC e BDC somente em instalações existentes com versões Windows que suportam os domínios NT4. A Red Hat recomenda não configurar um novo domínio Samba NT4, porque os sistemas operacionais Microsoft mais recentes que Windows 7 e Windows Server 2008 R2 não suportam os domínios NT4.

A Red Hat não suporta executar o Samba como controlador de domínio AD (DC).

Independentemente do modo de instalação, você pode opcionalmente compartilhar diretórios e impressoras. Isto permite que Samba atue como servidor de arquivos e impressão.

3.1. Entendendo os diferentes serviços e modos de Samba

Esta seção descreve os diferentes serviços incluídos no Samba e os diferentes modos que você pode configurar.

3.1.1. Os serviços de Samba

O Samba oferece os seguintes serviços:

smbdEste serviço oferece serviços de compartilhamento de arquivos e impressão usando o protocolo SMB. Além disso, o serviço é responsável pelo bloqueio de recursos e pela autenticação da conexão dos usuários. O serviço

smbsystemdinicia e pára o daemonsmbd.Para utilizar o serviço

smbd, instale o pacotesamba.nmbdEste serviço fornece nome do host e resolução IP usando o protocolo NetBIOS sobre IPv4. Além da resolução do nome, o serviço

nmbdpermite a navegação na rede SMB para localizar domínios, grupos de trabalho, hosts, compartilhamento de arquivos e impressoras. Para isso, o serviço ou reporta essas informações diretamente ao cliente de transmissão ou as encaminha a um navegador local ou mestre. O serviçonmbsystemdinicia e pára o daemonnmbd.Observe que as modernas redes SMB utilizam o DNS para resolver clientes e endereços IP.

Para utilizar o serviço

nmbd, instale o pacotesamba.winbinddEste serviço fornece uma interface para o Name Service Switch (NSS) para usar usuários e grupos de domínios AD ou NT4 no sistema local. Isto permite, por exemplo, que usuários de domínio se autentiquem em serviços hospedados em um servidor Samba ou em outros serviços locais. O serviço

winbindsystemdinicia e pára o daemonwinbindd.Se você configurar o Samba como um membro do domínio,

winbindddeve ser iniciado antes do serviçosmbd. Caso contrário, os usuários e grupos de domínio não estão disponíveis para o sistema local.Para utilizar o serviço

winbindd, instale o pacotesamba-winbind.ImportanteA Red Hat só suporta rodar Samba como servidor com o serviço

winbinddpara fornecer usuários e grupos de domínio para o sistema local. Devido a certas limitações, como a falta de suporte à lista de controle de acesso do Windows (ACL) e falha do NT LAN Manager (NTLM), o SSSD não é suportado.

3.1.2. Os serviços de segurança do Samba

O parâmetro security na seção [global] do arquivo /etc/samba/smb.conf gerencia como o Samba autentica os usuários que estão se conectando ao serviço. Dependendo do modo de instalação do Samba, o parâmetro deve ser definido para valores diferentes:

- Em um membro de domínio AD, conjunto

security = ads Neste modo, Samba usa o Kerberos para autenticar usuários AD.

Para detalhes sobre como configurar o Samba como membro do domínio, veja Seção 3.5, “Configurando o Samba como um servidor membro do domínio AD”.

- Em um servidor autônomo, conjunto

security = user Neste modo, Samba usa um banco de dados local para autenticar os usuários conectados.

Para detalhes sobre como configurar o Samba como um servidor autônomo, veja Seção 3.3, “Configurando o Samba como um servidor autônomo”.

- Em um NT4 PDC ou BDC, conjunto

security = user - Neste modo, o Samba autentica os usuários a um banco de dados local ou LDAP.

- Em um membro de domínio NT4, conjunto

security = domain Neste modo, o Samba autentica a conexão dos usuários a um NT4 PDC ou BDC. Você não pode usar este modo em membros do domínio AD.

Para detalhes sobre como configurar o Samba como membro do domínio, veja Seção 3.5, “Configurando o Samba como um servidor membro do domínio AD”.

Recursos adicionais

-

Veja a descrição do parâmetro

securityna página de manualsmb.conf(5).

3.1.3. Cenários quando os serviços Samba e as utilidades dos clientes Samba carregam e recarregam sua configuração

O seguinte descreve quando os serviços e utilitários Samba carregam e recarregam sua configuração:

Os serviços de Samba recarregam sua configuração:

- Automaticamente a cada 3 minutos

-

A pedido manual, por exemplo, quando você executa o comando

smbcontrol all reload-config.

- As utilidades do cliente Samba só lêem sua configuração quando você as inicia.

Note que certos parâmetros, tais como security requerem um reinício do serviço smb para entrar em vigor e uma recarga não é suficiente.

Recursos adicionais

-

A seção

How configuration changes are appliedna página de manualsmb.conf(5) -

As páginas de manual

smbd(8),nmbd(8), ewinbindd(8)

3.1.4. Editando a configuração do Samba de uma forma segura

Os serviços de Samba recarregam automaticamente sua configuração a cada 3 minutos. Este procedimento descreve como editar a configuração do Samba de forma a evitar que os serviços recarreguem as mudanças antes que você tenha verificado a configuração usando o utilitário testparm.

Pré-requisitos

- O Samba está instalado.

Procedimento

Crie uma cópia do arquivo

/etc/samba/smb.conf:#

cp /etc/samba/smb.conf /etc/samba/samba.conf.copy- Edite o arquivo copiado e faça as alterações desejadas.

Verificar a configuração no

/etc/samba/samba.conf.copyarquivo:#

testparm -s /etc/samba/samba.conf.copySe

testparmreportar erros, conserte-os e execute o comando novamente.Anular o arquivo

/etc/samba/smb.confcom a nova configuração:#

mv /etc/samba/samba.conf.copy /etc/samba/smb.confAguarde até que os serviços Samba recarreguem automaticamente sua configuração ou recarreguem manualmente a configuração:

#

smbcontrol all reload-config

3.2. Verificando a configuração do Samba

A Red Hat recomenda que você verifique a configuração do Samba cada vez que atualizar o arquivo /etc/samba/smb.conf. Esta seção fornece detalhes sobre isso.

3.2.1. Verificação do arquivo smb.conf usando o utilitário testparm

O utilitário testparm verifica se a configuração do Samba no arquivo /etc/samba/smb.conf está correta. O utilitário detecta parâmetros e valores inválidos, mas também configurações incorretas, tais como para o mapeamento de identificação. Se testparm não relatar nenhum problema, os serviços do Samba carregarão com sucesso o arquivo /etc/samba/smb.conf. Note que testparm não pode verificar se os serviços configurados estarão disponíveis ou funcionarão como esperado.

A Red Hat recomenda que você verifique o arquivo /etc/samba/smb.conf usando testparm após cada modificação deste arquivo.

Pré-requisitos

- Você instalou o Samba.

-

O arquivo

/etc/samba/smb.confsai.

Procedimento

Execute o utilitário

testparmcomo o usuárioroot:#

testparmLoad smb config files from /etc/samba/smb.conf rlimit_max: increasing rlimit_max (1024) to minimum Windows limit (16384) Unknown parameter encountered: "log levell" Processing section "[example_share]" Loaded services file OK. ERROR: The idmap range for the domain * (tdb) overlaps with the range of DOMAIN (ad)! Server role: ROLE_DOMAIN_MEMBER Press enter to see a dump of your service definitions # Global parameters [global] ... [example_share] ...O exemplo anterior informa um parâmetro inexistente e uma configuração de mapeamento de identificação incorreta.

-

Se

testparmrelatar parâmetros incorretos, valores ou outros erros na configuração, conserte o problema e execute novamente o utilitário.

3.3. Configurando o Samba como um servidor autônomo

Você pode configurar o Samba como um servidor que não é membro de um domínio. Neste modo de instalação, o Samba autentica os usuários a um banco de dados local ao invés de a um CD central. Além disso, você pode permitir o acesso de visitantes para permitir que os usuários se conectem a um ou vários serviços sem autenticação.

3.3.1. Configurando a configuração do servidor para o servidor autônomo

Esta seção descreve como configurar a configuração do servidor para um servidor autônomo Samba.

Procedimento

Instale o pacote

samba:#

yum install sambaEdite o arquivo

/etc/samba/smb.confe defina os seguintes parâmetros:[global] workgroup = Example-WG netbios name = Server security = user log file = /var/log/samba/%m.log log level = 1

Esta configuração define um servidor autônomo chamado

Serverdentro do grupo de trabalhoExample-WG. Além disso, esta configuração permite o logon em um nível mínimo (1) e os arquivos de log serão armazenados no diretório/var/log/samba/. Samba expandirá a macro%mno parâmetrolog filepara o nome NetBIOS de conexão de clientes. Isto permite arquivos de log individuais para cada cliente.Opcionalmente, configure o compartilhamento de arquivos ou impressoras. Veja:

Verifique o arquivo

/etc/samba/smb.conf:#

testparmSe você configurar ações que requerem autenticação, crie as contas de usuário.

Para maiores detalhes, ver Seção 3.3.2, “Criação e habilitação de contas de usuário locais”.

Abra as portas necessárias e recarregue a configuração do firewall, usando o utilitário

firewall-cmd:#

firewall-cmd --permanent --add-port={139/tcp,445/tcp}#firewall-cmd --reloadHabilite e inicie o serviço

smb:#

systemctl enable --now smb

Recursos adicionais

-

Para mais detalhes sobre os parâmetros utilizados no procedimento, veja as descrições dos parâmetros na página de manual

smb.conf(5).

3.3.2. Criação e habilitação de contas de usuário locais

Para que os usuários possam autenticar quando se conectam a uma ação, é necessário criar as contas no host Samba tanto no sistema operacional quanto no banco de dados Samba. O Samba requer a conta do sistema operacional para validar as Listas de Controle de Acesso (ACL) nos objetos do sistema de arquivos e a conta Samba para autenticar os usuários conectados.

Se você usar a configuração padrão passdb backend = tdbsam, Samba armazena as contas de usuário no banco de dados /var/lib/samba/private/passdb.tdb.

O procedimento nesta seção descreve como criar um usuário Samba local chamado example.

Pré-requisitos

- O Samba é instalado configurado como um servidor autônomo.

Procedimento

Criar a conta do sistema operacional:

#

useradd -M -s /sbin/nologin exampleEste comando adiciona a conta

examplesem criar um diretório home. Se a conta for usada apenas para autenticar no Samba, atribua o comando/sbin/nologincomo shell para evitar que a conta entre no sistema local.Defina uma senha para a conta do sistema operacional para habilitá-la:

#

passwd exampleEnter new UNIX password:passwordRetype new UNIX password:passwordpasswd: password updated successfullySamba não usa a senha definida na conta do sistema operacional para autenticar. Entretanto, é necessário definir uma senha para habilitar a conta. Se uma conta for desativada, o Samba negará o acesso se este usuário se conectar.

Adicione o usuário ao banco de dados do Samba e defina uma senha para a conta:

#

smbpasswd -a exampleNew SMB password:passwordRetype new SMB password:passwordAdded user example.Use esta senha para autenticar ao usar esta conta para se conectar a uma ação Samba.

Habilitar a conta Samba:

#

smbpasswd -e exampleEnabled user example.

3.4. Entendendo e configurando o mapeamento do Samba ID

Os domínios Windows distinguem usuários e grupos por Identificadores de Segurança (SID) exclusivos. Entretanto, o Linux requer UIDs e GIDs únicos para cada usuário e grupo. Se você executar Samba como membro do domínio, o serviço winbindd é responsável por fornecer informações sobre usuários e grupos de domínios para o sistema operacional.

Para habilitar o serviço winbindd a fornecer identificações únicas para usuários e grupos ao Linux, você deve configurar o mapeamento de identificação no arquivo /etc/samba/smb.conf para:

- O banco de dados local (domínio padrão)

- O domínio AD ou NT4 do qual o servidor Samba é membro

- Cada domínio confiável do qual os usuários devem ser capazes de acessar recursos neste servidor Samba

O Samba fornece diferentes back ends de mapeamento de identificação para configurações específicas. Os back ends mais freqüentemente utilizados são:

| Voltar ao final | Estojo de uso |

|---|---|

|

|

O domínio padrão |

|

| Somente domínios AD |

|

| Domínios AD e NT4 |

|

|

AD, NT4, e o domínio padrão |

3.4.1. Planejamento de gamas de identificação Samba

Independentemente de você armazenar os UIDs e GIDs Linux no AD ou se você configurar o Samba para gerá-los, cada configuração de domínio requer uma faixa de ID única que não deve se sobrepor a nenhum dos outros domínios.

Se você definir intervalos de identificação sobrepostos, o Samba não funciona corretamente.

Exemplo 3.1. Faixas de identificação exclusivas

A seguir são mostradas as faixas de mapeamento de identificação não sobrepostas para os domínios padrão (*), AD-DOM, e os domínios TRUST-DOM.

[global] ... idmap config * : backend = tdb idmap config * : range = 10000-999999 idmap config AD-DOM:backend = rid idmap config AD-DOM:range = 2000000-2999999 idmap config TRUST-DOM:backend = rid idmap config TRUST-DOM:range = 4000000-4999999

Você só pode atribuir uma faixa por domínio. Portanto, deixe espaço suficiente entre as faixas de domínios. Isto permite que você amplie a faixa mais tarde se seu domínio crescer.

Se posteriormente você atribuir uma faixa diferente a um domínio, a propriedade de arquivos e diretórios previamente criados por esses usuários e grupos será perdida.

3.4.2. The * default domain

Em um ambiente de domínio, você adiciona uma configuração de mapeamento de identificação para cada um dos seguintes itens:

- O domínio do servidor Samba é um membro do

- Cada domínio de confiança que deve ser capaz de acessar o servidor Samba

Entretanto, para todos os outros objetos, o Samba atribui IDs do domínio padrão. Isto inclui:

- Usuários e grupos locais de Samba

-

Contas e grupos incorporados no Samba, tais como

BUILTIN\Administrators

Você deve configurar o domínio padrão conforme descrito nesta seção para permitir que o Samba funcione corretamente.

O back end padrão do domínio deve ser gravável para armazenar permanentemente as identificações atribuídas.

Para o domínio padrão, você pode usar um dos seguintes back ends:

tdbQuando você configurar o domínio padrão para usar o back end

tdb, defina uma faixa de ID que seja grande o suficiente para incluir objetos que serão criados no futuro e que não façam parte de uma configuração definida de mapeamento de ID de domínio.Por exemplo, defina o seguinte na seção

[global]no arquivo/etc/samba/smb.conf:idmap config * : backend = tdb idmap config * : range = 10000-999999

Para mais detalhes, veja Seção 3.4.3, “Usando o tdb ID mapeamento back end”.

autoridQuando você configura o domínio padrão para usar o back end

autorid, a adição de configurações adicionais de mapeamento de ID para domínios é opcional.Por exemplo, defina o seguinte na seção

[global]no arquivo/etc/samba/smb.conf:idmap config * : backend = autorid idmap config * : range = 10000-999999

Para mais detalhes, veja Seção 3.4.6, “Usando o mapeamento de identificação autorídica back end”.

3.4.3. Usando o tdb ID mapeamento back end

O serviço winbindd usa o mapeamento de identificação por default tdb para armazenar as tabelas de mapeamento Security Identifier (SID), UID, e GID. Isto inclui usuários locais, grupos e principais incorporados.

Use este back end somente para o domínio padrão *. Por exemplo:

idmap config * : backend = tdb idmap config * : range = 10000-999999

Recursos adicionais

3.4.4. Usando o mapeamento de identificação do anúncio back end

Esta seção descreve como configurar um membro do Samba AD para usar o back end de mapeamento de ID ad.

O ad ID mapping back end implementa uma API somente leitura para ler as informações de conta e grupo do AD. Isto proporciona os seguintes benefícios:

- Todas as configurações de usuário e grupo são armazenadas centralmente em AD.

- As identificações de usuários e grupos são consistentes em todos os servidores Samba que utilizam este back end.

- As IDs não são armazenadas em um banco de dados local que pode corromper e, portanto, a propriedade dos arquivos não pode ser perdida.

O ad ID mapping back end não suporta domínios Active Directory com trusts unidirecionais. Se você configurar um membro do domínio em um Active Directory com trusts unidirecionais, use ao invés de um dos seguintes back ends de mapeamento de ID: tdb, rid, ou autorid.

A parte traseira do anúncio lê os seguintes atributos do AD:

| Nome do atributo AD | Tipo de objeto | Mapeado para |

|---|---|---|

|

| Usuário e grupo | Nome do usuário ou do grupo, dependendo do objeto |

|

| Usuário | ID do usuário (UID) |

|

| Grupo | ID do grupo (GID) |

|

| Usuário | Caminho para a casca do usuário |

|

| Usuário | Caminho para o diretório pessoal do usuário |

|

| Usuário | ID do grupo primário |

[a]

O Samba só lê este atributo se você definir idmap config DOMAIN:unix_nss_info = yes.

[b]

O Samba só lê este atributo se você definir idmap config DOMAIN:unix_primary_group = yes.

| ||

Pré-requisitos

-

Tanto os usuários quanto os grupos devem ter IDs únicos definidos no AD, e as IDs devem estar dentro do intervalo configurado no arquivo

/etc/samba/smb.conf. Objetos cujos IDs estão fora do intervalo não estarão disponíveis no servidor Samba. - Os usuários e grupos devem ter todos os atributos necessários definidos no AD. Se faltarem atributos requeridos, o usuário ou grupo não estará disponível no servidor Samba. Os atributos requeridos dependem de sua configuração. Pré-requisitos

- Você instalou o Samba.

-

A configuração do Samba, exceto o mapeamento de ID, existe no arquivo

/etc/samba/smb.conf.

Procedimento

Edite a seção

[global]no arquivo/etc/samba/smb.conf:Adicione uma configuração de mapeamento de identificação para o domínio padrão (

*) se ele não existir. Por exemplo:idmap config * : backend = tdb idmap config * : range = 10000-999999Habilite o back end do mapeamento de ID

adpara o domínio AD:idmap config DOMAIN: backend = adDefina a gama de IDs que é atribuída aos usuários e grupos no domínio AD. Por exemplo:

idmap config DOMAIN: intervalo = 2000000-2999999

ImportanteA faixa não deve se sobrepor a nenhuma outra configuração de domínio neste servidor. Além disso, o intervalo deve ser definido suficientemente grande para incluir todas as IDs atribuídas no futuro. Para mais detalhes, veja Seção 3.4.1, “Planejamento de gamas de identificação Samba”.

Defina que o Samba usa o esquema RFC 2307 ao ler os atributos do AD:

idmap config DOMAIN: schema_mode = rfc2307Para permitir que o Samba leia a shell de login e o caminho para o diretório home do usuário a partir do atributo AD correspondente, definido:

idmap config DOMAIN: unix_nss_info = simAlternativamente, você pode definir um caminho uniforme de diretório home e shell de login em todo o domínio que é aplicado a todos os usuários. Por exemplo:

template shell = /bin/bash template homedir = /home/%U

Por padrão, Samba usa o atributo

primaryGroupIDde um objeto de usuário como o grupo primário do usuário no Linux. Alternativamente, você pode configurar o Samba para usar o valor definido no atributogidNumber:idmap config DOMAIN: unix_primary_group = sim

Verifique o arquivo

/etc/samba/smb.conf:#

testparmRecarregar a configuração do Samba:

#

smbcontrol all reload-config

Recursos adicionais

- Seção 3.4.2, “The * default domain”

-

Para mais detalhes sobre os parâmetros utilizados no procedimento, consulte as páginas de manual

smb.conf(5)eidmap_ad(8). -

Para obter detalhes sobre substituição de variáveis, consulte a seção

VARIABLE SUBSTITUTIONSna página de manualsmb.conf(5).

3.4.5. Usando o mapeamento de identificação do rid back end

Esta seção descreve como configurar um membro do domínio Samba para usar o back end do mapeamento de ID rid.

O Samba pode usar o identificador relativo (RID) de um SID do Windows para gerar um ID no Red Hat Enterprise Linux.

O RID é a última parte de um SID. Por exemplo, se o SID de um usuário é S-1-5-21-5421822485-1151247151-421485315-30014, então 30014 é o RID correspondente.

O back end de mapeamento de ID rid implementa uma API somente leitura para calcular informações de contas e grupos com base em um esquema de mapeamento algorítmico para domínios AD e NT4. Quando você configura o back end, você deve definir o RID mais baixo e o mais alto no idmap config DOMAIN : range parâmetro. O Samba não mapeará usuários ou grupos com um RID menor ou maior do que o definido neste parâmetro.

Como back end só de leitura, rid não pode atribuir novas identificações, como para os grupos BUILTIN. Portanto, não utilize este back end para o domínio padrão *.

Benefícios de usar a parte traseira do carro

- Todos os usuários e grupos de domínio que têm um RID dentro do intervalo configurado estão automaticamente disponíveis no membro do domínio.

- Não é necessário atribuir manualmente IDs, diretórios residenciais e shells de login.

Problemas de usar a parte traseira do carro

- Todos os usuários de domínio recebem a mesma shell de login e diretório pessoal atribuídos. Entretanto, você pode usar variáveis.

-

Os IDs de usuários e grupos só são os mesmos entre os membros do domínio Samba se todos usarem o back end

ridcom as mesmas configurações de faixa de ID. - Você não pode excluir que usuários individuais ou grupos estejam disponíveis no membro do domínio. Somente usuários e grupos fora da faixa configurada são excluídos.

-

Com base nas fórmulas que o serviço

winbinddusa para calcular as IDs, podem ocorrer IDs duplicadas em ambientes de vários domínios se objetos em domínios diferentes tiverem o mesmo RID.

Pré-requisitos

- Você instalou o Samba.

-

A configuração do Samba, exceto o mapeamento de ID, existe no arquivo

/etc/samba/smb.conf.

Procedimento

Edite a seção

[global]no arquivo/etc/samba/smb.conf:Adicione uma configuração de mapeamento de identificação para o domínio padrão (

*) se ele não existir. Por exemplo:idmap config * : backend = tdb idmap config * : range = 10000-999999Habilite o back end do mapeamento de ID

ridpara o domínio:idmap config DOMAIN: backend = ridDefina uma faixa que seja suficientemente grande para incluir todos os RIDs que serão designados no futuro. Por exemplo:

idmap config DOMAIN: intervalo = 2000000-2999999

O Samba ignora usuários e grupos cujos RIDs neste domínio não estão dentro do alcance.

ImportanteA faixa não deve se sobrepor a nenhuma outra configuração de domínio neste servidor. Para mais detalhes, veja Seção 3.4.1, “Planejamento de gamas de identificação Samba”.

Defina um caminho de shell e diretório home que será atribuído a todos os usuários mapeados. Por exemplo:

template shell = /bin/bash template homedir = /home/%U

Verifique o arquivo

/etc/samba/smb.conf:#

testparmRecarregar a configuração do Samba:

#

smbcontrol all reload-configRecursos adicionais

- Seção 3.4.2, “The * default domain”

-

Para obter detalhes sobre substituição de variáveis, consulte a seção

VARIABLE SUBSTITUTIONSna página de manualsmb.conf(5). -

Para detalhes, como Samba calcula a identificação local a partir de um RID, consulte a página de manual

idmap_rid(8).

3.4.6. Usando o mapeamento de identificação autorídica back end

Esta seção descreve como configurar um membro do domínio Samba para usar o back end do mapeamento de ID autorid.

O back end autorid funciona similar ao back end de mapeamento de ID rid, mas pode atribuir automaticamente IDs para diferentes domínios. Isto permite utilizar o back end autorid nas seguintes situações:

-

Somente para o domínio padrão

* -

Para o domínio padrão

*e domínios adicionais, sem a necessidade de criar configurações de mapeamento de ID para cada um dos domínios adicionais - Somente para domínios específicos

Se você usar autorid para o domínio padrão, a adição de configuração adicional de mapeamento de ID para domínios é opcional.

Partes desta seção foram adotadas a partir da documentação autoridada do idmap config publicada no Samba Wiki. Licença: CC BY 4.0. Autores e colaboradores: Veja a aba histórico na página Wiki.

Benefícios de utilizar o back end do autorid

- Todos os usuários e grupos de domínio cujos UID e GID calculados estão dentro do intervalo configurado estão automaticamente disponíveis no membro do domínio.

- Não é necessário atribuir manualmente IDs, diretórios residenciais e shells de login.

- Nenhuma identificação duplicada, mesmo que vários objetos em um ambiente de vários domínios tenham o mesmo RID.

Drawbacks

- Os IDs de usuário e de grupo não são os mesmos entre os membros do domínio Samba.

- Todos os usuários de domínio recebem a mesma shell de login e diretório pessoal atribuídos. Entretanto, você pode usar variáveis.

- Você não pode excluir que usuários individuais ou grupos estejam disponíveis no membro do domínio. Somente usuários e grupos cujo UID ou GID calculado esteja fora da faixa configurada são excluídos.

Pré-requisitos

- Você instalou o Samba.

-

A configuração do Samba, exceto o mapeamento de ID, existe no arquivo

/etc/samba/smb.conf.

Procedimento

Edite a seção

[global]no arquivo/etc/samba/smb.conf:Habilite o back end do mapeamento de ID

autoridpara o domínio padrão*:idmap config * : backend = autorid

Defina um intervalo suficientemente grande para atribuir identificações para todos os objetos existentes e futuros. Por exemplo:

idmap config * : range = 10000-999999O Samba ignora usuários e grupos cujos IDs calculados neste domínio não estão dentro do intervalo.

AtençãoApós definir a faixa e o Samba começar a usá-la, você só pode aumentar o limite superior da faixa. Qualquer outra mudança no intervalo pode resultar em novas atribuições de ID e, portanto, na perda da propriedade dos arquivos.

Opcionalmente, defina um tamanho de faixa. Por exemplo, o tamanho da gama:

idmap config * : rangesize = 200000Samba assigns this number of continuous IDs for each domain’s object until all IDs from the range set in the

idmap config * : rangeparameter are taken.Defina um caminho de shell e diretório home que será atribuído a todos os usuários mapeados. Por exemplo:

template shell = /bin/bash template homedir = /home/%U

Opcionalmente, adicione configuração adicional de mapeamento de identificação para domínios. Se nenhuma configuração para um domínio individual estiver disponível, Samba calcula o ID usando as configurações do back end

autoridno domínio padrão*previamente configurado.ImportanteSe você configurar back ends adicionais para domínios individuais, os intervalos para todas as configurações de mapeamento de identificação não devem se sobrepor. Para mais detalhes, veja Seção 3.4.1, “Planejamento de gamas de identificação Samba”.

Verifique o arquivo

/etc/samba/smb.conf:#

testparmRecarregar a configuração do Samba:

#

smbcontrol all reload-config

Recursos adicionais

-

Para detalhes sobre como o back end calculou os IDs, consulte a seção

THE MAPPING FORMULASna página de manualidmap_autorid(8). -

Para obter detalhes sobre o uso do parâmetro

idmap configrangesize, consulte a descrição do parâmetrorangesizena página de manualidmap_autorid(8). -

Para obter detalhes sobre substituição de variáveis, consulte a seção

VARIABLE SUBSTITUTIONSna página de manualsmb.conf(5).

3.5. Configurando o Samba como um servidor membro do domínio AD

Se você estiver rodando um domínio AD ou NT4, use Samba para adicionar seu servidor Red Hat Enterprise Linux como membro ao domínio para ganhar o seguinte:

- Acessar recursos de domínio em outros membros do domínio

-

Autenticar usuários de domínio para serviços locais, tais como

sshd - Compartilhar diretórios e impressoras hospedadas no servidor para atuar como um servidor de arquivos e impressão

3.5.1. Juntando um sistema RHEL a um domínio AD

Esta seção descreve como unir um sistema Red Hat Enterprise Linux a um domínio AD, usando realmd para configurar o Samba Winbind.

Procedimento

Se seu AD requer o tipo de criptografia RC4 obsoleto para autenticação Kerberos, habilite o suporte para estas cifras na RHEL:

#

update-crypto-policies --set DEFAULT:AD-SUPPORTInstale os seguintes pacotes:

#

yum install realmd oddjob-mkhomedir oddjob samba-winbind-clients \ samba-winbind samba-common-tools samba-winbind-krb5-locatorPara compartilhar diretórios ou impressoras no membro do domínio, instale o pacote

samba:#

yum install sambaFaça o backup do arquivo de configuração existente

/etc/samba/smb.confSamba:#

mv /etc/samba/smb.conf /etc/samba/smb.conf.bakJunte-se ao domínio. Por exemplo, para ingressar em um domínio chamado

ad.example.com:#

realm join --membership-software=samba --client-software=winbind ad.example.comUsando o comando anterior, o utilitário

realmautomaticamente:-

Cria um arquivo

/etc/samba/smb.confpara uma associação no domínioad.example.com -

Adiciona o módulo

winbindpara pesquisas de usuários e grupos ao arquivo/etc/nsswitch.conf -

Atualiza os arquivos de configuração do Módulo de Autenticação Pluggável (PAM) no diretório

/etc/pam.d/ -

Inicia o serviço

winbinde permite que o serviço seja iniciado quando o sistema inicia

-

Cria um arquivo

-

Opcionalmente, defina um mapeamento alternativo de identificação no back end ou configurações personalizadas de mapeamento de identificação no arquivo

/etc/samba/smb.conf. Para detalhes, veja Seção 3.4, “Entendendo e configurando o mapeamento do Samba ID”. Verifique se o serviço

winbindestá funcionando:#

systemctl status winbind... Active: active (running) since Tue 2018-11-06 19:10:40 CET; 15s agoImportantePara que o Samba possa consultar informações de usuários e grupos de domínio, o serviço

winbinddeve estar em execução antes de você iniciarsmb.Se você instalou o pacote

sambapara compartilhar diretórios e impressoras, ative e inicie o serviçosmb:#

systemctl enable --now smb-

Opcionalmente, se você estiver autenticando os logins locais no Active Directory, ative o plug-in

winbind_krb5_localauth. Veja Seção 3.5.2, “Usando o plug-in de autorização local para o MIT Kerberos”.

Etapas de verificação

Exibir os detalhes de um usuário AD, tais como a conta do administrador AD no domínio AD:

#

getent passwd "AD\administrator"AD\administrator:*:10000:10000::/home/administrator@AD:/bin/bashConsultar os membros do grupo de usuários do domínio no domínio AD:

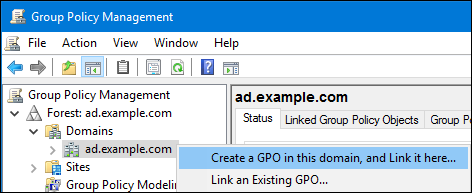

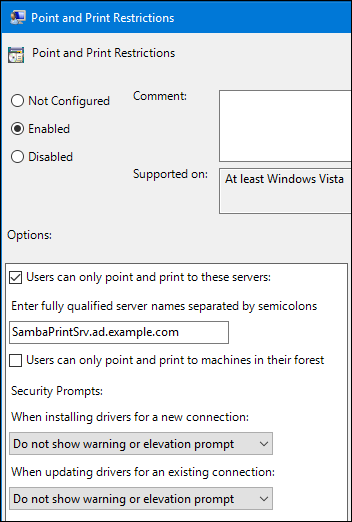

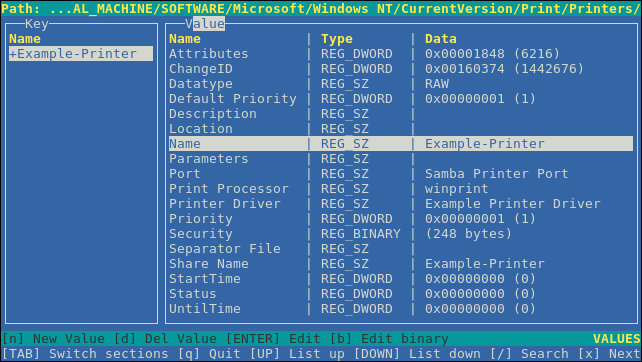

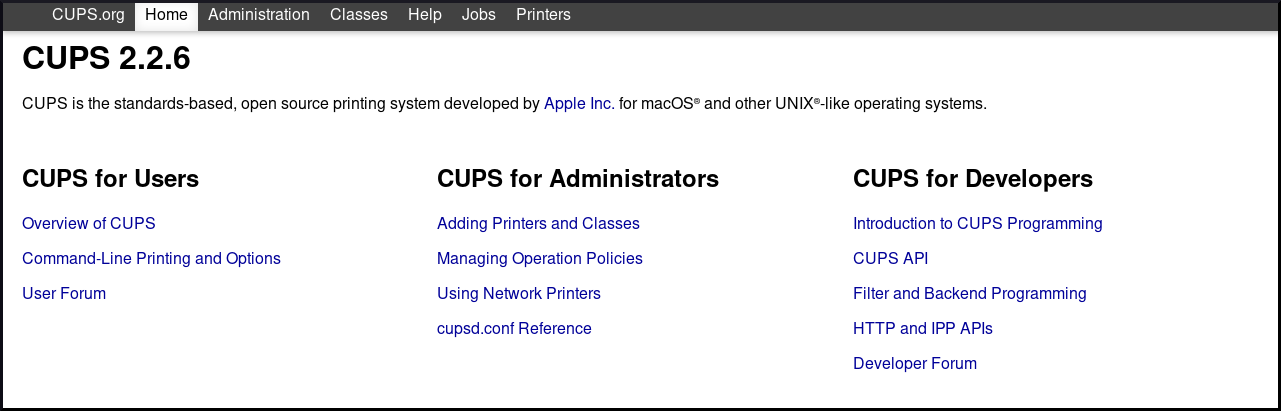

#