Red Hat Training

A Red Hat training course is available for RHEL 8

37장. 스토리지 중복 및 압축

37.1. VDO 배포

시스템 관리자는 VDO를 사용하여 중복 및 압축된 스토리지 풀을 만들 수 있습니다.

37.1.1. VDO 소개

VDO(가상 데이터 최적화 도구)는 중복 제거, 압축 및 씬 프로비저닝 형태로 Linux에 대한 인라인 데이터를 제공합니다. VDO 볼륨을 설정할 때 VDO 볼륨과 제공하려는 논리 스토리지를 구성할 블록 장치를 지정합니다.

- 활성 VM 또는 컨테이너를 호스팅하는 경우, 10:1 논리에서 물리적 비율로 스토리지를 프로비저닝하는 것이 좋습니다. 즉 1TB의 물리 스토리지를 사용하는 경우 10TB의 논리 스토리지로 제공됩니다.

- Ceph에서 제공하는 유형과 같은 개체 스토리지의 경우 3:1 논리적 대 물리적 비율을 사용할 것을 권장합니다. 즉, 1TB의 물리적 스토리지가 3TB 논리적 스토리지로 제공됩니다.

두 경우 모두 VDO에서 제공하는 논리 장치 상단에 파일 시스템을 배치한 다음 직접 또는 분산 클라우드 스토리지 아키텍처의 일부로 사용할 수 있습니다.

VDO는 씬 프로비저닝되므로 파일 시스템과 애플리케이션은 사용 중인 논리 공간만 표시하며 사용 가능한 실제 공간을 인식하지 못합니다. 스크립팅을 사용하여 실제 사용 가능한 공간을 모니터링하고 를 사용하여 임계값을 초과하는 경우(예: VDO 볼륨이 80%인 경우) 경고를 생성합니다.

37.1.2. VDO 배포 시나리오

다음과 같이 중복된 저장소를 제공하는 다양한 방법으로 VDO를 배포할 수 있습니다.

- 블록 및 파일 액세스

- 로컬 및 원격 스토리지

VDO는 중복된 스토리지를 표준 Linux 블록 장치로 노출하기 때문에 표준 파일 시스템, iSCSI 및 FC 대상 드라이버 또는 통합 스토리지로 사용할 수 있습니다.

현재 Ceph RADOS Block Device(RBD) 상단에 VDO 볼륨 배포가 지원됩니다. 그러나 VDO 볼륨 상단에 Red Hat Ceph Storage 클러스터 구성 요소 배포는 현재 지원되지 않습니다.

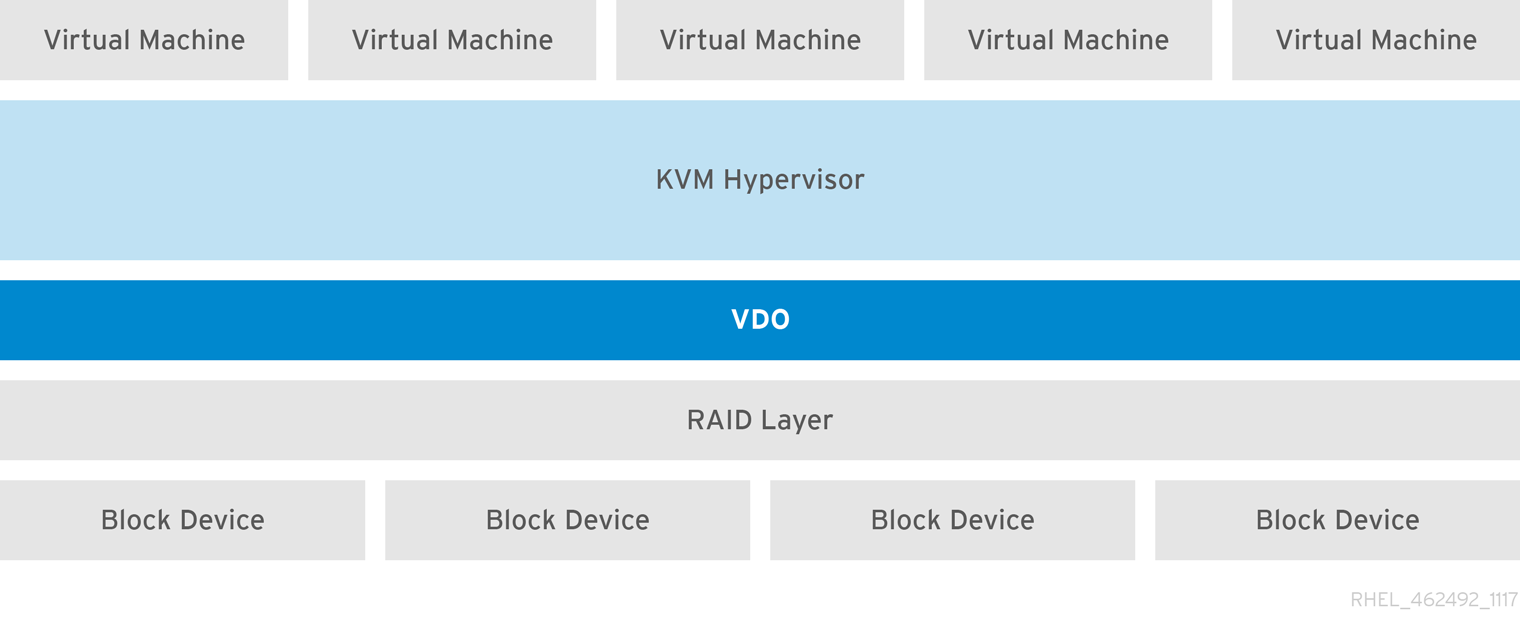

KVM

Direct Attached Storage로 구성된 KVM 서버에 VDO를 배포할 수 있습니다.

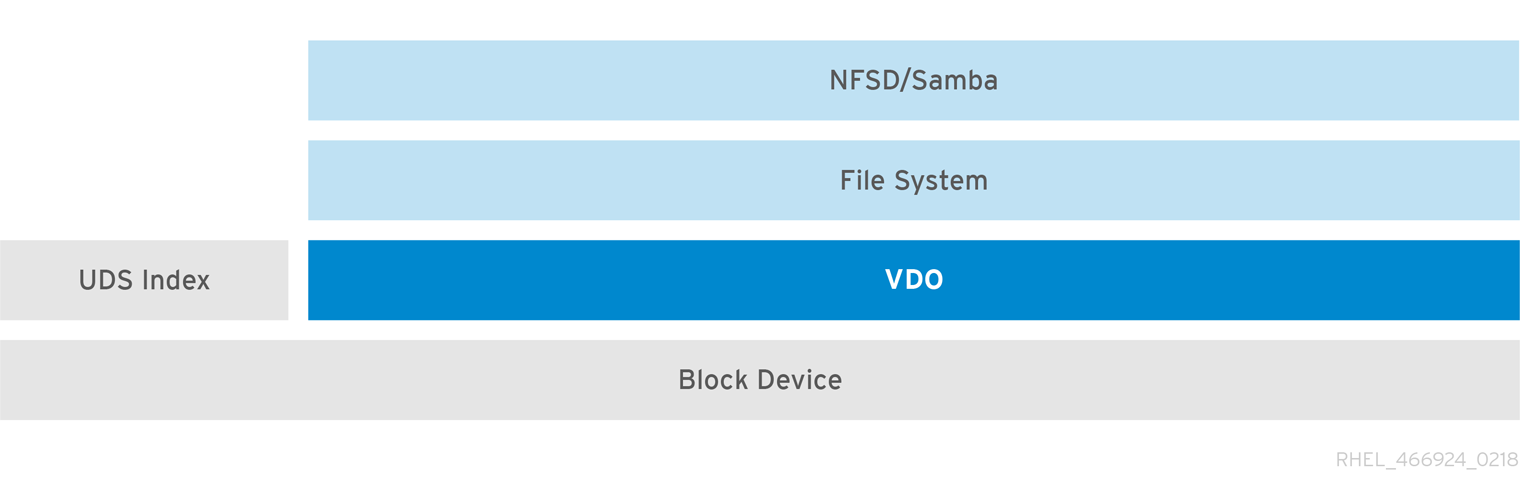

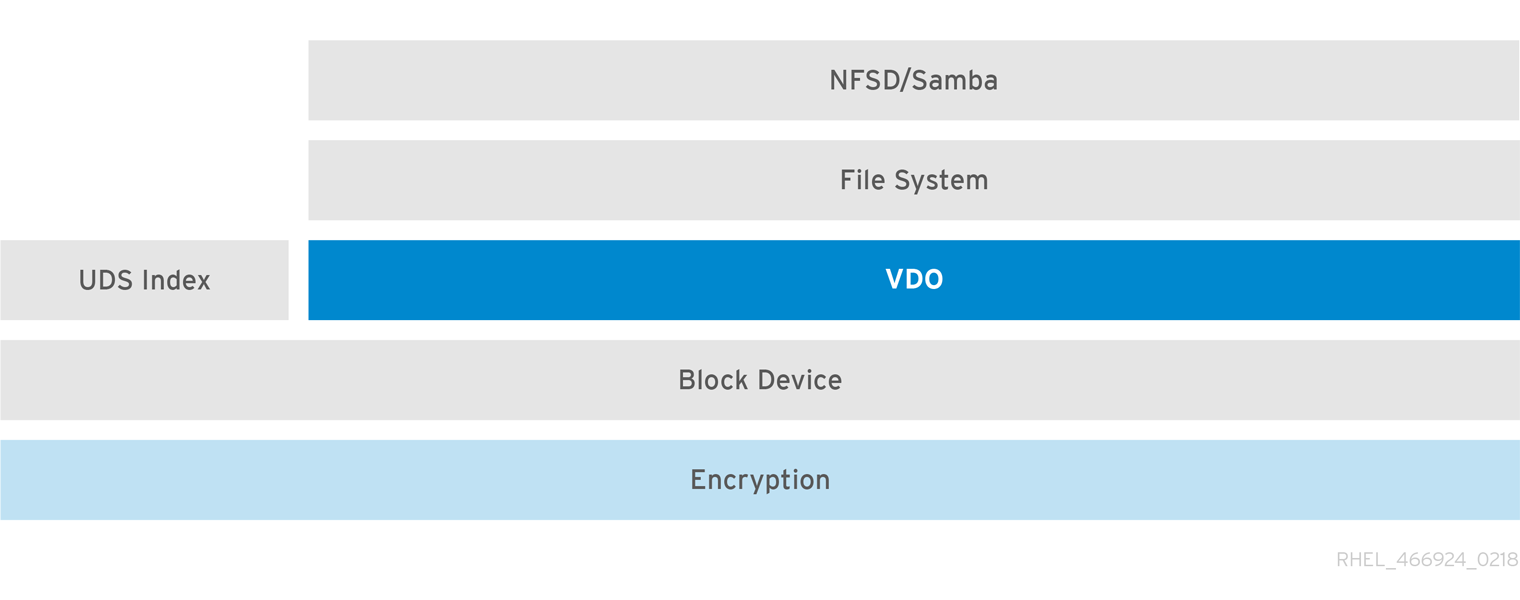

파일 시스템

VDO 상단에서 파일 시스템을 생성하고 NFS 서버 또는 Samba를 사용하여 NFS 또는 CIFS 사용자에게 노출할 수 있습니다.

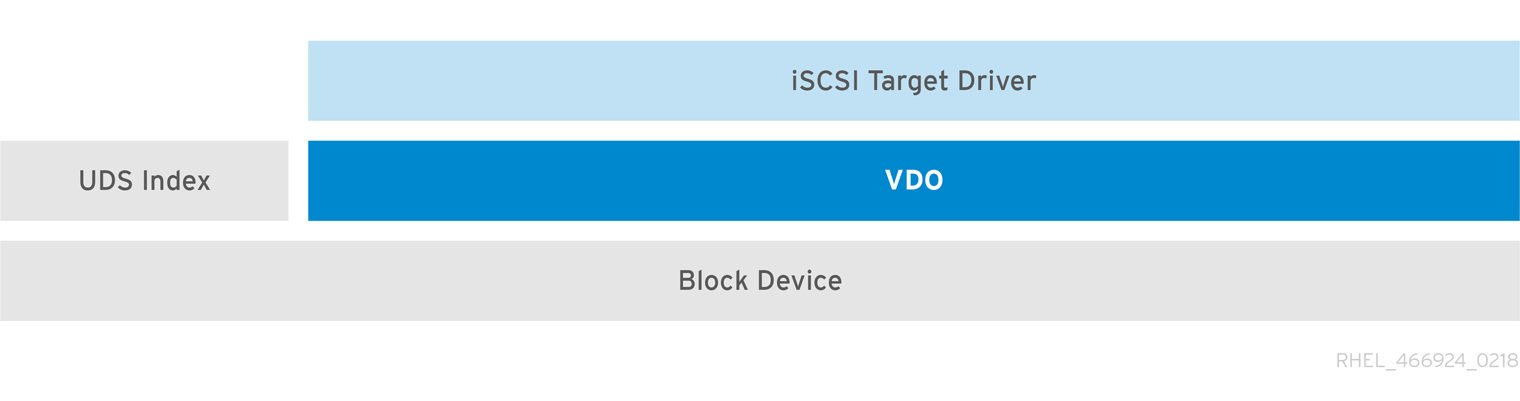

iSCSI에 VDO 배치

VDO 스토리지 대상의 전체를 원격 iSCSI 이니시에이터의 iSCSI 대상으로 내보낼 수 있습니다.

iSCSI에 VDO 볼륨을 생성할 때 VDO 볼륨을 iSCSI 계층 위에 배치하거나 아래에 배치할 수 있습니다. 고려해야 할 여러 가지가 있지만 환경에 가장 적합한 방법을 선택하는 데 도움이 되는 몇 가지 지침이 제공됩니다.

iSCSI 계층 아래의 iSCSI 서버(대상)에 VDO 볼륨을 배치할 때:

- VDO 볼륨은 다른 iSCSI LUN과 유사하게 이니시에이터와 투명합니다. 클라이언트로부터 씬 프로비저닝과 공간 절약을 숨기면 LUN을 보다 쉽게 모니터링하고 유지 관리할 수 있습니다.

- VDO 메타데이터가 읽기 또는 쓰기가 없기 때문에 네트워크 트래픽이 줄어들고 중복 장치에 대한 읽기 검증이 네트워크에서 발생하지 않기 때문입니다.

- iSCSI 대상에서 사용 중인 메모리 및 CPU 리소스가 성능이 향상될 수 있습니다. 예를 들어 iSCSI 대상에서 볼륨 감소가 수행되기 때문에 증가된 하이퍼바이저 수를 호스트하는 기능이 있습니다.

- 클라이언트가 이니시에이터에서 암호화를 구현하고 대상 아래에 VDO 볼륨이 있는 경우 공간 절감을 실현하지 않습니다.

iSCSI 계층 위의 iSCSI 클라이언트(initiator)에 VDO 볼륨을 배치할 때:

- 높은 수준의 공간 절약을 달성하면 ASYNC 모드에서 네트워크에서 네트워크 트래픽이 줄어들 수 있습니다.

- 공간 절약을 직접 보고 제어하고 사용량을 모니터링할 수 있습니다.

-

예를 들어

dm-crypt를 사용하여 데이터를 암호화하려면 crypt 위에서 VDO를 구현하고 공간 효율성을 활용할 수 있습니다.

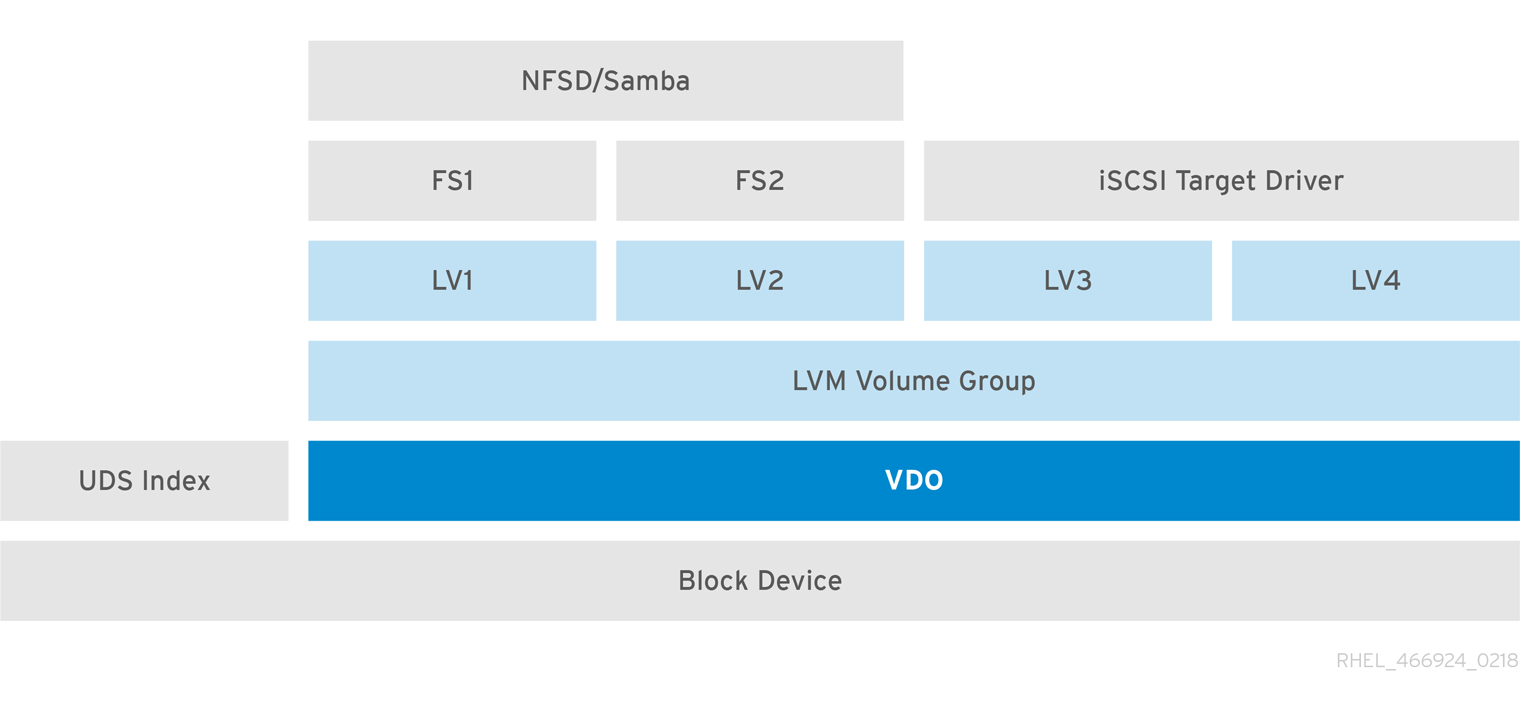

LVM

기능이 더 많은 시스템에서 LVM을 사용하여 동일한 중복 스토리지 풀에서 모두 지원하는 여러 LUN(Logical Unit Number)을 제공할 수 있습니다.

다음 다이어그램에서 VDO 대상은 LVM에서 관리할 수 있도록 물리 볼륨으로 등록됩니다. 여러 논리 볼륨(RPC1 에서 LV4까지)이 deduplicated 스토리지 풀에서 생성됩니다. 이러한 방식으로 VDO는 기본 중복 스토리지 풀에 대한 다중 프로토콜 통합 블록 또는 파일 액세스를 지원할 수 있습니다.

중복된 통합 스토리지 설계를 통해 여러 파일 시스템이 LVM 툴을 통해 동일한 중복 제거 도메인을 공동으로 사용할 수 있습니다. 또한 파일 시스템은 VDO 상단에 LVM 스냅샷, COW(Copy-On-Write) 및 축소 또는 증가 기능을 활용할 수 있습니다.

Encryption

DM Crypt와 같은 DM(Device Mapper) 메커니즘은 VDO와 호환됩니다. VDO 볼륨을 암호화하면 데이터 보안 및 VDO 위의 모든 파일 시스템이 여전히 중복됩니다.

VDO 위의 암호화 계층을 적용하면 데이터 중복 제거가 거의 발생하지 않습니다. 암호화는 VDO를 복제하기 전에 중복 블록을 다르게 만듭니다.

항상 VDO 아래에 암호화 계층을 배치합니다.

iSCSI에 VDO 볼륨을 생성할 때 VDO 볼륨을 iSCSI 계층 위에 배치하거나 아래에 배치할 수 있습니다. 고려해야 할 여러 가지가 있지만 환경에 가장 적합한 방법을 선택하는 데 도움이 되는 몇 가지 지침이 제공됩니다.

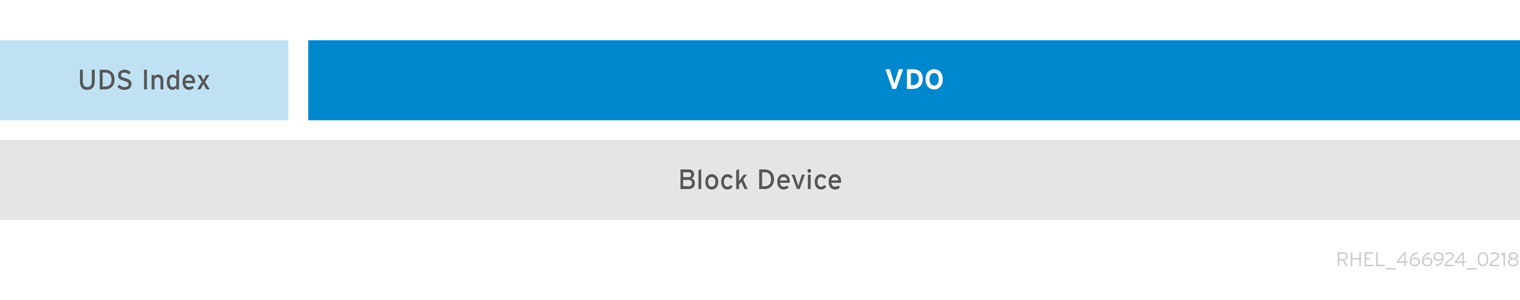

37.1.3. VDO 볼륨의 구성 요소

VDO는 블록 장치를 백업 저장소로 사용합니다. 여기에는 하나 이상의 디스크, 파티션 또는 플랫 파일로 구성된 물리적 스토리지 집계가 포함될 수 있습니다. 스토리지 관리 도구가 VDO 볼륨을 생성할 때 VDO는 UDS 인덱스 및 VDO 볼륨을 위한 볼륨 공간을 예약합니다. UDS 인덱스 및 VDO 볼륨은 서로 상호 작용하여 중복된 블록 스토리지를 제공합니다.

그림 37.1. VDO 디스크 조직

VDO 솔루션은 다음 구성 요소로 구성됩니다.

kvdoLinux 장치 매퍼 계층에 로드되는 커널 모듈은 중복되고 압축되며 씬 프로비저닝된 블록 스토리지 볼륨을 제공합니다.

kvdo모듈은 블록 장치를 노출합니다. 블록 스토리지를 위해 이 블록 장치에 직접 액세스하거나 XFS 또는 ext4와 같은 Linux 파일 시스템을 통해 제공할 수 있습니다.kvdo가 VDO 볼륨에서 데이터의 논리 블록을 읽기 위한 요청을 수신하면 요청된 논리 블록을 기본 물리적 블록에 매핑한 다음 요청된 데이터를 읽고 반환합니다.kvdo가 VDO 볼륨에 데이터 블록을 쓰기 위한 요청을 수신하면 먼저 요청이 DISCARD 또는 TRIM 요청인지 또는 데이터가 균일하게 0인지 여부를 확인합니다. 이러한 조건 중 하나가 true이면kvdo는 블록 맵을 업데이트하고 요청을 승인합니다. 그렇지 않으면 VDO는 데이터를 처리하고 최적화합니다.UDS볼륨의 Universal Deduplication Service(UDS) 인덱스와 통신하는 커널 모듈이며 중복을 위해 데이터를 분석합니다. 새로운 데이터의 각 부분에 대해 UDS는 이전에 저장된 데이터 조각과 동일한지 빠르게 결정합니다. 인덱스가 일치하는 항목을 찾으면 스토리지 시스템은 동일한 정보를 두 번 이상 저장하지 않도록 기존 항목을 내부적으로 참조할 수 있습니다.

UDS 인덱스는

uds커널 모듈로 커널 내부에서 실행됩니다.- 명령줄 툴

- 최적화된 스토리지를 구성하고 관리하는 데 사용됩니다.

37.1.4. VDO 볼륨의 물리 및 논리적 크기

VDO는 다음과 같은 방법으로 물리적, 사용 가능한 물리적 크기 및 논리 크기를 활용합니다.

- 물리적 크기

이는 기본 블록 장치와 크기가 동일합니다. VDO는 다음 용도로 이 스토리지를 사용합니다.

- 사용자 데이터가 분할되고 압축될 수 있습니다.

- VDO 메타데이터(예: UDS 인덱스)

- 사용 가능한 물리적 크기

이는 VDO가 사용자 데이터에 사용할 수 있는 물리적 크기의 부분입니다.

물리 크기와 같습니다. 메타데이터의 크기를 뺀 후 나머지 볼륨을 지정된 slab 크기로 slabs로 분할한 후 나머지를 뺀 값입니다.

- 논리 크기

이는 VDO 볼륨이 애플리케이션에 제공하는 프로비저닝된 크기입니다. 일반적으로 사용 가능한 물리적 크기보다 큽니다.

--vdoLogicalSize옵션이 지정되지 않은 경우 논리 볼륨의 프로비저닝이 이제1:1비율로 프로비저닝됩니다. 예를 들어 VDO 볼륨이 20GB 블록 장치 위에 배치된 경우 UDS 인덱스(기본 인덱스 크기가 사용되는 경우) 2.5GB가 예약되어 있습니다. 나머지 17.5GB는 VDO 메타데이터 및 사용자 데이터에 제공됩니다. 결과적으로 사용할 수 있는 스토리지는 17.5GB를 초과하지 않으며 실제 VDO 볼륨을 구성하는 메타데이터로 인해 줄어들 수 있습니다.VDO는 현재 최대 논리 크기가 4PB인 물리 볼륨의 크기를 254배까지 지원합니다.

그림 37.2. VDO 디스크 조직

이 그림에서 VDO 중복된 스토리지 대상은 블록 장치의 상단에 완전히 배치되므로 VDO 볼륨의 물리적 크기는 기본 블록 장치와 같습니다.

추가 리소스

- 다른 크기의 블록 장치에 필요한 스토리지 VDO 메타데이터의 양에 대한 자세한 내용은 37.1.6.4절. “물리적 크기별 VDO 요구 사항의 예” 을 참조하십시오.

37.1.5. VDO의 Slab 크기

VDO 볼륨의 물리 스토리지는 여러 slabs로 나뉩니다. 각 스lab은 물리적 공간의 연속된 영역입니다. 지정된 볼륨에 대한 모든 slabs의 크기는 같으며, 이는 128MB에서 최대 32GB의 2개의 전원을 사용할 수 있습니다.

기본 slab 크기는 작은 테스트 시스템에서 VDO를 쉽게 평가할 수 있도록 2GB입니다. 하나의 VDO 볼륨은 최대 8192 개의 slabs를 가질 수 있습니다. 따라서 2GB slabs를 사용하는 기본 구성에서 허용되는 최대 물리 스토리지는 16TB입니다. 32GB slabs를 사용하는 경우 허용되는 최대 물리 스토리지는 256TB입니다. VDO는 항상 메타데이터를 위해 하나 이상의 전체 slab을 예약하므로 예약된 slab은 사용자 데이터를 저장하는 데 사용할 수 없습니다.

Slab 크기는 VDO 볼륨의 성능에 영향을 미치지 않습니다.

표 37.1. 물리 볼륨 크기에 따른 VDO 스lab 크기 권장

| 물리 볼륨 크기 | 권장되는 Slab 크기 |

|---|---|

| 10-99GB | 1GB |

| 100GB - 1TB | 2GB |

| 2-256 TB | 32GB |

기본 설정 2GB slab 크기와 0.25 밀도 인덱스를 사용하는 VDO 볼륨의 최소 디스크 사용량에는 approx 4.7GB가 필요합니다. 이는 0% 중복 제거 또는 압축에서 쓸 수 있는 2GB의 물리적 데이터보다 약간 적습니다.

여기에서 최소 디스크 사용은 기본 slab 크기 및 dense 인덱스의 합계입니다.

lvcreate 명령에 --config 'allocation/vdo_slab_size_mb=size-in- megabytesbytes' 옵션을 제공하여 slab 크기를 제어할 수 있습니다.

37.1.6. VDO 요구 사항

VDO에는 배치 및 시스템 리소스에 대한 특정 요구 사항이 있습니다.

37.1.6.1. VDO 메모리 요구 사항

각 VDO 볼륨에는 두 가지 고유한 메모리 요구 사항이 있습니다.

- VDO 모듈

VDO에는 고정된 38MB의 RAM 및 여러 가지 변수 양이 필요합니다.

- 구성된 블록 맵 캐시 크기의 1MB마다 1.15MB의 RAM입니다. 블록 맵 캐시에는 최소 150MB의 RAM이 필요합니다.

- 1TB의 논리 공간당 1.6MB의 RAM.

- 볼륨에서 관리하는 물리 스토리지 1TB마다 268MB의 RAM입니다.

- UDS 인덱스

Universal Deduplication Service(UDS)에는 최소 250MB의 RAM이 필요하며 이는 중복 제거에서 사용하는 기본 용량이기도 합니다. VDO 볼륨을 포맷할 때 값을 구성할 수 있습니다. 이 값은 인덱스에 필요한 스토리지 양에도 영향을 미치기 때문입니다.

UDS 인덱스에 필요한 메모리는 인덱스 유형 및 중복 제거 창의 필요한 크기에 따라 결정됩니다.

인덱스 유형 중복 제거 창 참고 밀도

1GB RAM당 1GB

일반적으로 1GB 밀도의 인덱스는 최대 4TB의 물리적 스토리지에 충분합니다.

스파스

1GB RAM당 10GB

1GB 스파스 인덱스는 일반적으로 최대 40TB의 물리적 스토리지에 충분합니다.

참고기본 설정 2GB slab 크기와 0.25 밀도 인덱스를 사용하는 VDO 볼륨의 최소 디스크 사용량에는 approx 4.7GB가 필요합니다. 이는 0% 중복 제거 또는 압축에서 쓸 수 있는 2GB의 물리적 데이터보다 약간 적습니다.

여기에서 최소 디스크 사용은 기본 slab 크기 및 dense 인덱스의 합계입니다.

UDS Sparse Indexing 기능은 VDO에 권장되는 모드입니다. 데이터의 일시적인 지역성을 사용하며 메모리에서 가장 관련 있는 인덱스 항목만 유지하려고 시도합니다. 스파스 인덱스에서 UDS는 밀도와 동일한 양의 메모리를 사용하는 것보다 10배 더 큰 중복 제거 창을 유지할 수 있습니다.

스파스 인덱스가 가장 큰 범위를 제공하지만 dense 인덱스는 더 많은 중복 제거 조언을 제공합니다. 대부분의 워크로드에서 동일한 양의 메모리가 주어지면 밀도와 스파스 인덱스 간의 중복 제거 속도가 무효화될 수 있습니다.

추가 리소스

37.1.6.2. VDO 스토리지 공간 요구사항

VDO 볼륨은 최대 256TB의 물리적 스토리지를 사용하도록 구성할 수 있습니다. 물리적 스토리지의 특정 부분만 데이터를 저장하는 데 사용할 수 있습니다. 이 섹션에서는 VDO 관리 볼륨의 사용 가능한 크기를 결정하는 계산을 제공합니다.

VDO에는 두 가지 유형의 VDO 메타데이터와 UDS 인덱스에 대한 스토리지가 필요합니다.

- VDO 메타데이터의 첫 번째 유형은 4GB의 물리적 스토리지에 대해 약 1MB를 사용하고 slab당 추가 1MB를 사용합니다.

- VDO 메타데이터의 두 번째 유형은 1GB의 논리 스토리지에 대해 약 1.25MB를 사용하며 가장 가까운 slab으로 반올림됩니다.

- UDS 인덱스에 필요한 스토리지 크기는 인덱스 유형과 인덱스에 할당된 RAM 크기에 따라 달라집니다. 1GB의 RAM에 대해 밀도가 높은 UDS 인덱스는 17GB의 스토리지를 사용하며 스파스 UDS 인덱스는17GB의 스토리지를 사용합니다.

추가 리소스

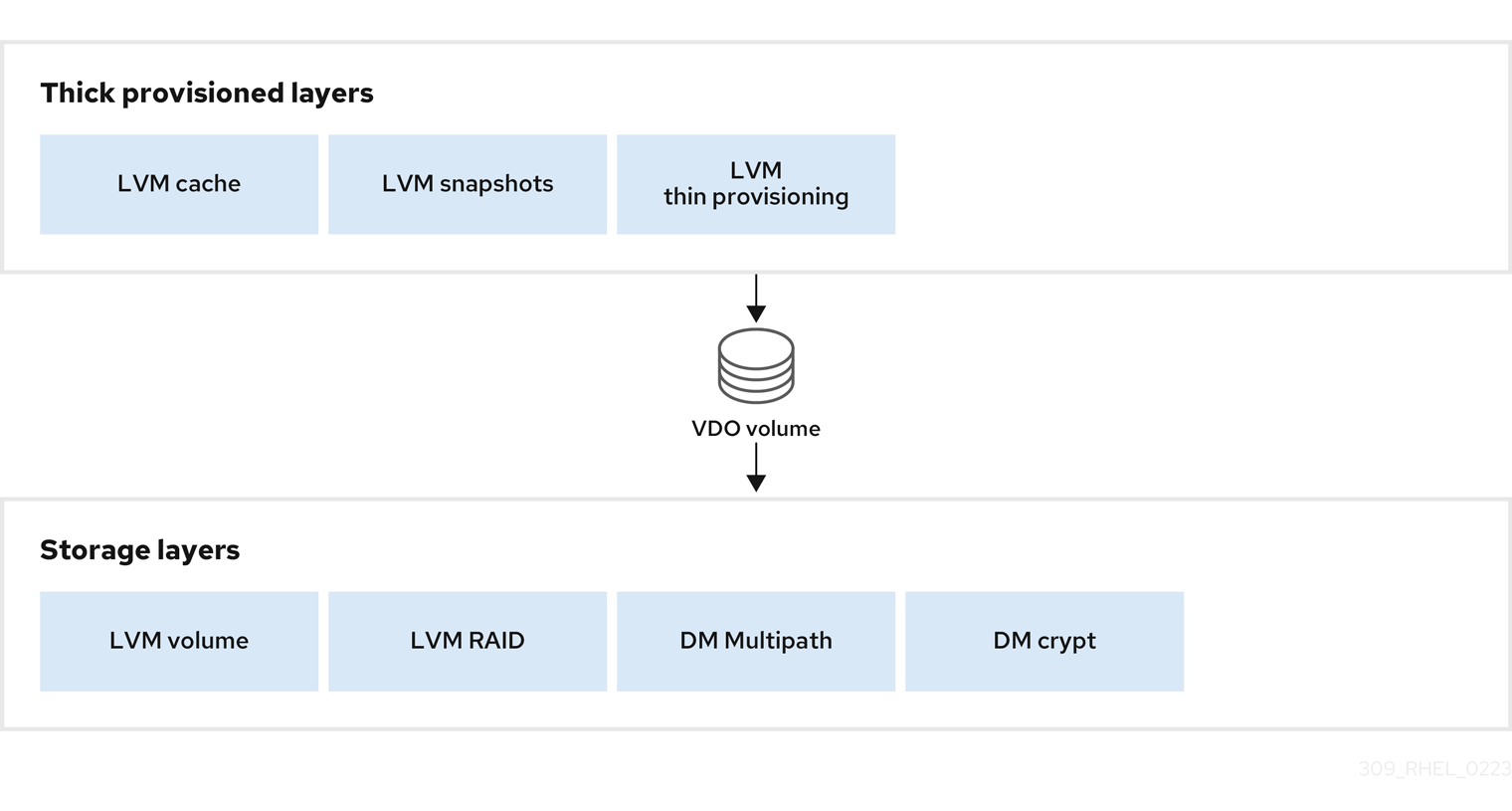

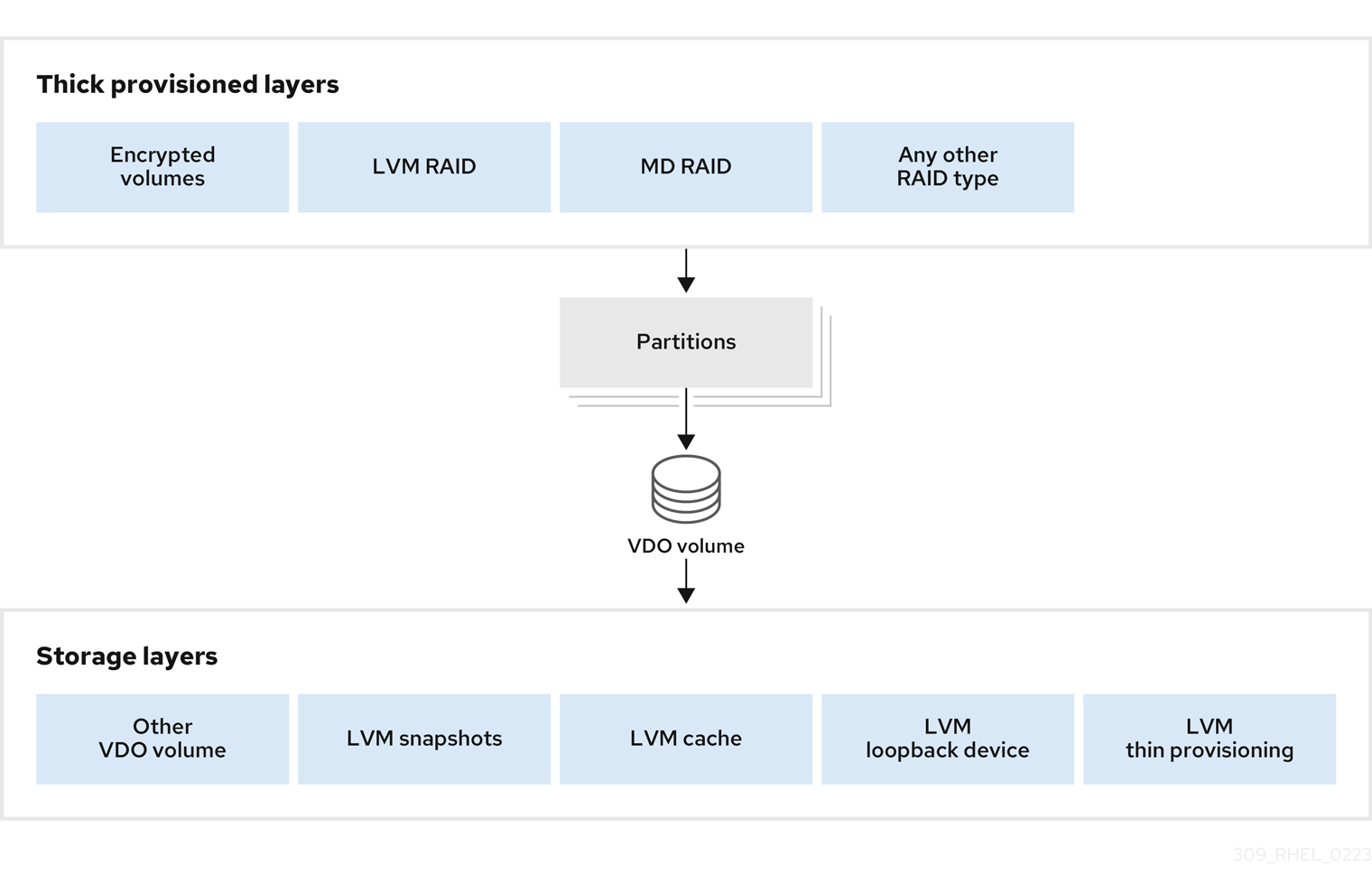

37.1.6.3. 스토리지 스택에 VDO 배치

배치 요구 사항에 맞게 스토리지 계층을 위 또는 VDO(Virtual Data Optimizer)에 배치합니다.

VDO 볼륨은 씬 프로비저닝된 블록 장치입니다. 나중에 확장할 수 있는 스토리지 계층 위에 볼륨을 배치하여 물리적 공간이 부족해지는 것을 방지할 수 있습니다. 이러한 확장 가능한 스토리지의 예로는 LVM(Logical Volume Manager) 볼륨 또는 다중 장치 Redundant Array Inexpensive(Expersive Disks) 배열이 있습니다.

VDO 위에 번거롭게 프로비저닝된 레이어를 배치 할 수 있습니다. 맹렬한 프로비저닝 계층에는 다음 두 가지 측면을 고려해야 합니다.

- 사용되지 않는 논리 공간에 새 데이터를 기록하면 두려운 장치에서 새 데이터를 작성합니다. VDO 또는 기타 씬 프로비저닝된 스토리지를 사용하는 경우 장치는 이러한 쓰기 작업 중에 공간이 부족함을 보고할 수 있습니다.

- 새로운 데이터가 있는 두려운 장치에서 논리 공간을 덮어 씁니다. VDO를 사용할 때 데이터를 덮어 쓰기하면 장치 공간이 부족해질 수 있습니다.

이러한 제한은 VDO 계층 위의 모든 계층에 영향을 미칩니다. VDO 장치를 모니터링하지 않으면 VDO 위의 맹렬한 프로비저닝 볼륨에서 예기치 않게 물리적 공간을 실행할 수 있습니다.

지원되는 VDO 볼륨 구성의 다음 예제를 참조하십시오.

그림 37.3. 지원되는 VDO 볼륨 구성

그림 37.4. 지원되지 않는 VDO 볼륨 구성

추가 리소스

- LVM 계층을 사용하여 VDO를 누적하는 방법에 대한 자세한 내용은 LVM 볼륨 스택 문서를 참조하십시오.

37.1.6.4. 물리적 크기별 VDO 요구 사항의 예

다음 표에서는 기본 볼륨의 물리적 크기에 따라 VDO의 대략적인 시스템 요구 사항을 제공합니다. 각 표에는 기본 스토리지 또는 백업 스토리지와 같은 원하는 배포에 적합한 요구 사항이 나열됩니다.

정확한 숫자는 VDO 볼륨의 구성에 따라 다릅니다.

- 기본 스토리지 배포

기본 스토리지 경우 UDS 인덱스는 물리 크기의 크기가 0.01%에서 25% 사이입니다.

표 37.2. 기본 스토리지에 대한 스토리지 및 메모리 요구 사항

물리적 크기 RAM 사용: UDS RAM 사용: VDO 디스크 사용량 인덱스 유형 10GB–1TB

250MB

472MB

2.5GB

밀도

2-10TB

1GB

3GB

10GB

밀도

250MB

22GB

스파스

11-50TB

2GB

14GB

170GB

스파스

51-100TB

3GB

27GB

255GB

스파스

101–256TB

12GB

69GB

1020GB

스파스

- 백업 스토리지 배포

백업 스토리지 경우 UDS 인덱스는 백업 세트의 크기를 다루지만 물리적 크기보다 크지는 않습니다. 백업 세트 또는 물리적 크기가 나중에 증가할 것으로 예상하는 경우 이를 인덱스 크기로 가져옵니다.

표 37.3. 백업 스토리지를 위한 스토리지 및 메모리 요구 사항

물리적 크기 RAM 사용: UDS RAM 사용: VDO 디스크 사용량 인덱스 유형 10GB–1TB

250MB

472MB

2.5GB

밀도

2-10TB

2GB

3GB

170GB

스파스

11-50TB

10GB

14GB

850GB

스파스

51-100TB

20GB

27GB

1700GB

스파스

101–256TB

26GB

69GB

3400GB

스파스

37.1.7. VDO 설치

이 절차에서는 VDO 볼륨을 생성, 마운트 및 관리하는 데 필요한 소프트웨어를 설치합니다.

절차

VDO 소프트웨어를 설치합니다.

# yum install lvm2 kmod-kvdo vdo

37.1.8. VDO 볼륨 생성

이 절차에서는 블록 장치에 VDO 볼륨을 생성합니다.

사전 요구 사항

- VDO 소프트웨어를 설치합니다. 37.1.7절. “VDO 설치”을 참조하십시오.

- 확장 가능한 스토리지를 백업 블록 장치로 사용합니다. 자세한 내용은 37.1.6.3절. “스토리지 스택에 VDO 배치”의 내용을 참조하십시오.

절차

다음 모든 단계에서 EgressIP -name 을 VDO 볼륨에 사용하려는 식별자로 바꿉니다(예:${1) . 시스템에서 VDO의 각 인스턴스에 다른 이름과 장치를 사용해야합니다.

VDO 볼륨을 생성할 블록 장치의 영구 이름을 찾습니다. 영구 이름에 대한 자세한 내용은 26장. 영구 이름 지정 특성 개요 을 참조하십시오.

비영구 장치 이름을 사용하는 경우 장치 이름이 변경되면 VDO가 나중에 제대로 시작되지 않을 수 있습니다.

VDO 볼륨을 생성합니다.

# vdo create \ --name=vdo-name \ --device=block-device \ --vdoLogicalSize=logical-size-

block-device 를 VDO 볼륨을 생성할 블록 장치의 영구 이름으로 교체합니다. 예를 들어

/dev/disk/by-id/scsi-3600508b1001c264ad2af21e903ad031f입니다. logical-size 를 VDO 볼륨이 제공해야 하는 논리 스토리지 양으로 교체합니다.

-

활성 VM 또는 컨테이너 스토리지의 경우 블록 장치의 물리적 크기가 10 배인 논리 크기를 사용합니다. 예를 들어, 블록 장치의 크기가 1TB인 경우 여기에서

10T를 사용하십시오. -

오브젝트 스토리지의 경우 블록 장치의 물리적 크기를 세 배인 논리 크기를 사용합니다. 예를 들어, 블록 장치의 크기가 1TB인 경우 여기에서

3T를 사용하십시오.

-

활성 VM 또는 컨테이너 스토리지의 경우 블록 장치의 물리적 크기가 10 배인 논리 크기를 사용합니다. 예를 들어, 블록 장치의 크기가 1TB인 경우 여기에서

물리 블록 장치가 16TiB보다 큰 경우

--vdoSlabSize=32G옵션을 추가하여 볼륨의 slab 크기를 32GiB로 늘립니다.16TiB 이상의 블록 장치에서 기본 slab 크기2GiB를 사용하면 EgressIP

create명령이 다음과 같은 오류로 인해 실패합니다.vdo: ERROR - vdoformat: formatVDO failed on '/dev/device': VDO Status: Exceeds maximum number of slabs supported

예 37.1. 컨테이너 스토리지용 VDO 생성

예를 들어 1TB 블록 장치에서 컨테이너 스토리지에 대한 VDO 볼륨을 생성하려면 다음을 사용할 수 있습니다.

# vdo create \ --name=vdo1 \ --device=/dev/disk/by-id/scsi-3600508b1001c264ad2af21e903ad031f \ --vdoLogicalSize=10T중요VDO 볼륨을 만들 때 오류가 발생하면 정리할 볼륨을 제거합니다. 자세한 내용은 실패한 VDO 볼륨 제거를 참조하십시오.

-

block-device 를 VDO 볼륨을 생성할 블록 장치의 영구 이름으로 교체합니다. 예를 들어

VDO 볼륨 상단에 파일 시스템을 생성합니다.

XFS 파일 시스템의 경우:

# mkfs.xfs -K /dev/mapper/vdo-nameext4 파일 시스템의 경우:

# mkfs.ext4 -E nodiscard /dev/mapper/vdo-name참고새로 생성된 VDO 볼륨에서

-K및-E nodiscard옵션의 용도는 할당되지 않은 블록에 영향을 미치지 않으므로 요청을 보내는 데 시간을 소비하지 않는 것입니다. 새로운 VDO 볼륨은 할당되지 않은 100%를 시작합니다.

다음 명령을 사용하여 시스템이 새 장치 노드를 등록할 때까지 기다립니다.

# udevadm settle

다음 단계

- 파일 시스템을 마운트합니다. 자세한 내용은 37.1.9절. “VDO 볼륨 마운트” 를 참조하십시오.

-

VDO 장치에서 파일 시스템의

삭제기능을 활성화합니다. 자세한 내용은 37.1.10절. “주기적인 블록 삭제 활성화” 를 참조하십시오.

추가 리소스

-

Egress

IP(8)도움말 페이지

37.1.9. VDO 볼륨 마운트

이 절차에서는 수동으로 또는 영구적으로 VDO 볼륨에 파일 시스템을 마운트합니다.

사전 요구 사항

- 시스템에 VDO 볼륨이 생성되었습니다. 자세한 내용은 37.1.8절. “VDO 볼륨 생성”에서 참조하십시오.

절차

VDO 볼륨에 파일 시스템을 수동으로 마운트하려면 다음을 사용합니다.

# mount /dev/mapper/vdo-name mount-point

부팅 시 자동으로 마운트되도록 파일 시스템을 구성하려면

/etc/fstab파일에 행을 추가합니다.XFS 파일 시스템의 경우:

/dev/mapper/vdo-name mount-point xfs defaults 0 0

ext4 파일 시스템의 경우:

/dev/mapper/vdo-name mount-point ext4 defaults 0 0

VDO 볼륨이 iSCSI와 같은 네트워크가 필요한 블록 장치에 있는 경우

_netdev마운트 옵션을 추가합니다.

추가 리소스

-

thank

(8)도움말 페이지. -

네트워크가 필요한 iSCSI 및 기타 블록 장치의 경우

_netdev마운트 옵션에 대한 자세한 내용은systemd.mount(5)매뉴얼 페이지를 참조하십시오.

37.1.10. 주기적인 블록 삭제 활성화

이 절차를 수행하면 지원되는 모든 파일 시스템에서 사용하지 않는 블록을 정기적으로 삭제하는 systemd 타이머가 활성화됩니다.

절차

systemd타이머를 활성화하고 시작합니다.# systemctl enable --now fstrim.timer

37.1.11. VDO 모니터링

이 절차에서는 VDO 볼륨에서 사용 및 효율성 정보를 얻는 방법을 설명합니다.

사전 요구 사항

- VDO 소프트웨어를 설치합니다. VDO 설치를 참조하십시오.

절차

EgressIP

stats유틸리티를 사용하여 VDO 볼륨에 대한 정보를 가져옵니다.# vdostats --human-readable Device 1K-blocks Used Available Use% Space saving% /dev/mapper/node1osd1 926.5G 21.0G 905.5G 2% 73% /dev/mapper/node1osd2 926.5G 28.2G 898.3G 3% 64%

추가 리소스

-

TYPE

stats(8)도움말 페이지.