운영 가이드

Red Hat Ceph Storage 운영 작업

초록

1장. Ceph Orchestrator 소개

스토리지 관리자는 Ceph Orchestrator를 Cephadm 유틸리티와 함께 사용하면 Red Hat Ceph Storage 클러스터에서 장치를 검색하고 서비스를 생성할 수 있습니다.

1.1. Ceph Orchestrator 사용

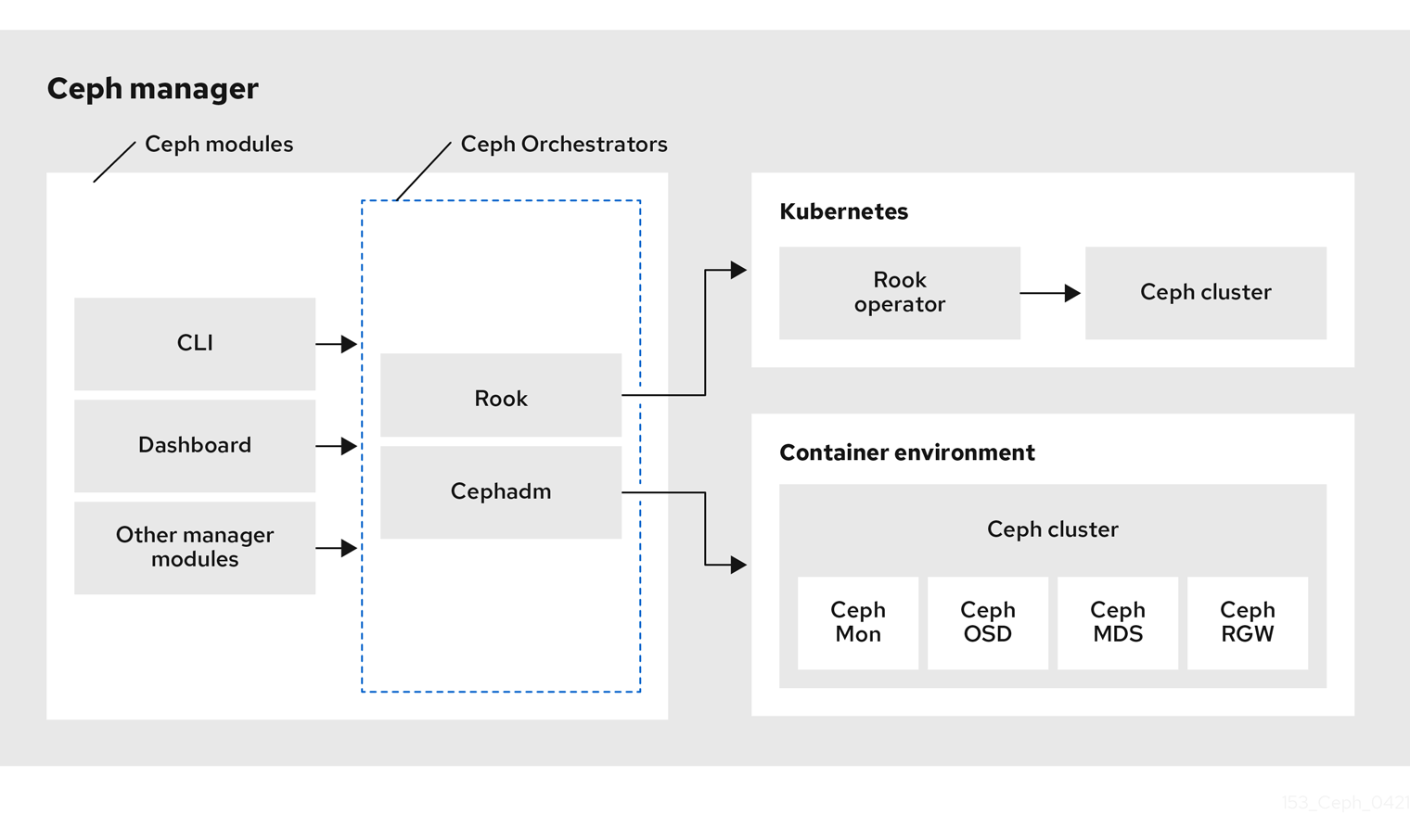

Red Hat Ceph Storage Orchestrators는 Red Hat Ceph Storage 클러스터와 Rook 및 Cephadm과 같은 배포 툴 간의 브리지 역할을 하는 관리자 모듈입니다. 또한 Ceph 명령줄 인터페이스 및 Ceph 대시보드와 통합됩니다.

다음은 Ceph Orchestrator의 워크플로우 다이어그램입니다.

Red Hat Ceph Storage Orchestrators

Red Hat Ceph Storage Orchestrators에는 세 가지 주요 유형이 있습니다.

오케스트레이터 CLI : Orchestrators에서 사용되는 일반적인 API이며 구현할 수 있는 명령 세트를 포함합니다. 이러한 API는 외부 오케스트레이션 서비스를 사용하여

ceph-mgr모듈을 오케스트레이션하는 공통 CLI(명령줄 인터페이스)도 제공합니다. 다음은 Ceph Orchestrator와 함께 사용되는 nomenclature입니다.- host: Pod 이름, DNS 이름, 컨테이너 이름 또는 컨테이너 내부의 호스트 이름이 아닌 물리적 호스트의 호스트 이름입니다.

- 서비스 유형: nfs, mds, osd, mon, rgw, mgr과 같은 서비스 유형입니다.

- Service : 모니터 서비스, 관리자 서비스, OSD 서비스, Ceph Object Gateway 서비스 및 NFS 서비스와 같은 Ceph 스토리지 클러스터에서 제공하는 기능 서비스입니다.

- 데몬: Ceph Object Gateway 서비스와 같은 하나 이상의 호스트에서 배포한 서비스의 특정 인스턴스는 세 개의 다른 호스트에서 실행되는 다른 Ceph Object Gateway 데몬을 사용할 수 있습니다.

cephadm Orchestrator - Rook 또는 Ansible과 같은 외부 툴에 의존하지 않고 SSH 연결을 설정하고 명시적 관리 명령을 실행하여 클러스터의 노드를 관리하는 Ceph Orchestrator 모듈입니다. 이 모듈은 Day-one 및 day-two 작업을 위한 것입니다.

Cephadm Orchestrator를 사용하면 Ansible과 같은 배포 프레임워크를 활용하지 않고도 Ceph 스토리지 클러스터를 설치하는 것이 좋습니다. 이 개념은 관리자 데몬에 스토리지 장치의 인벤토리 생성, OSD 배포 및 교체 또는 Ceph 데몬 시작 및 중지와 같은 관리 작업을 수행하기 위해 클러스터의 모든 노드에 연결할 수 있는 SSH 구성 및 키에 대한 액세스 권한을 제공하는 것입니다. 또한 Cephadm Orchestrator는 공동 배치된 서비스의 독립적인 업그레이드를 위해

systemd에서 관리하는 컨테이너 이미지를 배포합니다.이 오케스트레이터는 Ceph Monitor 및 Ceph Manager를 실행하는 최소 클러스터를 부트스트랩하는 명령을 포함하여 현재 호스트에서 컨테이너 이미지 기반 서비스 배포를 관리하는 데 필요한 모든 작업을 캡슐화하는 툴도 강조 표시합니다.

Rook Orchestrator - Rook은 Kubernetes Rook Operator를 사용하여 Kubernetes 클러스터 내에서 실행되는 Ceph 스토리지 클러스터를 관리하는 오케스트레이션 툴입니다. rook 모듈은 Ceph Orchestrator 프레임워크와 Rook 간의 통합을 제공합니다. Rook은 Kubernetes용 오픈 소스 클라우드 네이티브 스토리지 운영자입니다.

Rook은 "operator" 모델을 따르며, 여기에서 CRD(사용자 정의 리소스 정의) 오브젝트가 Ceph 스토리지 클러스터 및 원하는 상태를 설명하는 Kubernetes에 정의되어 있으며, rook Operator 데몬은 현재 클러스터 상태를 원하는 상태와 비교하고 이를 통합하기 위한 단계를 수행하는 컨트롤 루프에서 실행되고 있습니다. Ceph의 원하는 상태를 설명하는 기본 오브젝트는 Ceph 스토리지 클러스터 CRD입니다. 여기에는 OSD에서 사용해야 하는 장치, 실행 중인 모니터 수 및 사용할 Ceph 버전에 대한 정보가 포함됩니다. Rook은 RBD 풀, CephFS 파일 시스템 등을 설명하는 여러 다른 CRD를 정의합니다.

Rook Orchestrator 모듈은

ceph-mgr데몬에서 실행되고 원하는 클러스터 상태를 설명하는 Kubernetes의 Ceph 스토리지 클러스터를 변경하여 Ceph 오케스트레이션 API를 구현하는 접착제 모듈입니다. Rook 클러스터의ceph-mgr데몬은 Kubernetes pod로 실행되므로 rook 모듈은 명시적 구성없이 Kubernetes API에 연결할 수 있습니다.

2장. Ceph Orchestrator를 사용한 서비스 관리

Red Hat Ceph Storage 클러스터를 설치한 후 스토리지 관리자는 Ceph Orchestrator를 사용하여 스토리지 클러스터의 서비스를 모니터링하고 관리할 수 있습니다. 서비스는 함께 구성된 데몬 그룹입니다.

이 섹션에서는 다음 관리 정보를 다룹니다.

2.1. Ceph Orchestrator 배치 사양

Ceph Orchestrator를 사용하여 osds,mons,mgrs ,mds, rgw 서비스를 배포할 수 있습니다. 배치 사양을 사용하여 서비스를 배포하는 것이 좋습니다. Ceph Orchestrator를 사용하여 서비스를 배포하기 위해 배치해야 하는 데몬 수와 위치를 알아야 합니다. 배치 사양은 명령줄 인수로 전달하거나 yaml 파일에서 서비스 사양으로 전달할 수 있습니다.

배치 사양을 사용하여 서비스를 배포하는 방법은 다음 두 가지가 있습니다.

명령줄 인터페이스에서 직접 배치 사양 사용. 예를 들어 호스트에 세 개의 모니터를 배포하려면 다음 명령을 실행하면

host01,host02,host03에 세 개의 모니터가 배포됩니다.예제

[ceph: root@host01 /]# ceph orch apply mon --placement="3 host01 host02 host03"

YAML 파일에서 배치 사양 사용. 예를 들어

node-exporter를 모든 호스트에 배포하려면yaml파일에서 다음을 지정할 수 있습니다.예제

service_type: node-exporter placement: host_pattern: '*' extra_entrypoint_args: - "--collector.textfile.directory=/var/lib/node_exporter/textfile_collector2"

2.2. 명령줄 인터페이스를 사용하여 Ceph 데몬 배포

Ceph Orchestrator를 사용하면 ceph orch 명령을 사용하여 Ceph Manager, Ceph Monitors, Ceph OSD, 모니터링 스택 등과 같은 데몬을 배포할 수 있습니다. 배치 사양은 Orchestrator 명령을 사용하여 --placement 인수로 전달됩니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 호스트는 스토리지 클러스터에 추가됩니다.

프로세스

Cephadm 쉘에 로그인합니다.

예제

[root@host01 ~]# cephadm shell

다음 방법 중 하나를 사용하여 호스트에 데몬을 배포합니다.

방법 1: 데몬 수와 호스트 이름을 지정합니다.

구문

ceph orch apply SERVICE_NAME --placement="NUMBER_OF_DAEMONS HOST_NAME_1 HOST_NAME_2 HOST_NAME_3"

예제

[ceph: root@host01 /]# ceph orch apply mon --placement="3 host01 host02 host03"

방법 2: 호스트에 레이블을 추가한 다음 라벨을 사용하여 데몬을 배포합니다.

호스트에 레이블을 추가합니다.

구문

ceph orch host label add HOSTNAME_1 LABEL

예제

[ceph: root@host01 /]# ceph orch host label add host01 mon

라벨을 사용하여 데몬을 배포합니다.

구문

ceph orch apply DAEMON_NAME label:LABEL

예제

ceph orch apply mon label:mon

방법 3: 호스트에 레이블을 추가하고

--placement인수를 사용하여 배포합니다.호스트에 레이블을 추가합니다.

구문

ceph orch host label add HOSTNAME_1 LABEL

예제

[ceph: root@host01 /]# ceph orch host label add host01 mon

라벨 배치 사양을 사용하여 데몬을 배포합니다.

구문

ceph orch apply DAEMON_NAME --placement="label:LABEL"

예제

ceph orch apply mon --placement="label:mon"

검증

서비스를 나열합니다.

예제

[ceph: root@host01 /]# ceph orch ls

호스트, 데몬 및 프로세스를 나열합니다.

구문

ceph orch ps --daemon_type=DAEMON_NAME ceph orch ps --service_name=SERVICE_NAME

예제

[ceph: root@host01 /]# ceph orch ps --daemon_type=mon [ceph: root@host01 /]# ceph orch ps --service_name=mon

추가 리소스

- Red Hat Ceph Storage 운영 가이드 의 Ceph Orchestrator 섹션을 사용하여 호스트 추가 섹션을 참조하십시오.

2.3. 명령줄 인터페이스를 사용하여 호스트 하위 세트에 Ceph 데몬 배포

--placement 옵션을 사용하여 호스트 하위 세트에 데몬을 배포할 수 있습니다. 데몬을 배포할 호스트 이름으로 배치 사양의 데몬 수를 지정할 수 있습니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 호스트가 클러스터에 추가됩니다.

프로세스

Cephadm 쉘에 로그인합니다.

예제

[root@host01 ~]# cephadm shell

Ceph 데몬을 배포할 호스트를 나열합니다.

예제

[ceph: root@host01 /]# ceph orch host ls

데몬을 배포합니다.

구문

ceph orch apply SERVICE_NAME --placement="NUMBER_OF_DAEMONS HOST_NAME_1 _HOST_NAME_2 HOST_NAME_3"

예제

ceph orch apply mgr --placement="2 host01 host02 host03"

이 예에서는

mgr데몬은 두 호스트에만 배포됩니다.

검증

호스트를 나열합니다.

예제

[ceph: root@host01 /]# ceph orch host ls

추가 리소스

- Red Hat Ceph Storage 운영 가이드 의 Ceph Orchestrator 섹션을 사용하여 호스트 목록을 참조하십시오.

2.4. Ceph Orchestrator의 서비스 사양

서비스 사양은 Ceph 서비스를 배포하는 데 사용되는 서비스 속성 및 구성 설정을 지정하는 데이터 구조입니다. 다음은 서비스 사양을 지정하는 다중 문서 YAML 파일 cluster.yaml 의 예입니다.

예제

service_type: mon placement: host_pattern: "mon*" --- service_type: mgr placement: host_pattern: "mgr*" --- service_type: osd service_id: default_drive_group placement: host_pattern: "osd*" data_devices: all: true

다음 목록은 서비스 사양의 속성이 다음과 같이 정의되는 매개변수입니다.

service_type: 서비스 유형입니다.- mon, crash, mds, mgr, osd, rbd, rbd-mirror와 같은 Ceph 서비스.

- nfs 또는 rgw와 같은 Ceph 게이트웨이.

- Alertmanager, Prometheus, Grafana 또는 Node-exporter와 같은 모니터링 스택.

- 사용자 지정 컨테이너용 컨테이너입니다.

-

service_id: 서비스의 고유 이름입니다. -

placement: 데몬 배포 위치와 방법을 정의하는 데 사용됩니다. -

Unmanaged:true로 설정하면 Orchestrator는 이 서비스와 연결된 데몬을 배포하거나 제거하지 않습니다.

Orchestrators의 상태 비저장 서비스

상태 비저장 서비스는 상태 정보를 사용할 수 없는 서비스입니다. 예를 들어 rgw 서비스를 시작하려면 서비스를 시작하거나 실행하는 데 추가 정보가 필요하지 않습니다. rgw 서비스는 기능을 제공하기 위해 이 상태에 대한 정보를 생성하지 않습니다. rgw 서비스가 언제 시작되는지와 관계없이 상태는 동일합니다.

2.5. 데몬 자동 관리 비활성화

서비스 사양을 편집하고 다시 적용하지 않고도 Cephadm 서비스를 관리 또는 관리되지 않음 으로 표시할 수 있습니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 모든 노드에 대한 루트 수준 액세스.

프로세스

다음 명령을 사용하여 서비스에 대해

Unmanaged를 설정합니다.구문

ceph orch set-unmanaged SERVICE_NAME예제

[root@host01 ~]# ceph orch set-unmanaged grafana

다음 명령을 사용하여 서비스에 대해

managed를 설정합니다.구문

ceph orch set-managed SERVICE_NAME예제

[root@host01 ~]# ceph orch set-managed mon

2.6. 서비스 사양을 사용하여 Ceph 데몬 배포

Ceph Orchestrator를 사용하면 YAML 파일의 서비스 사양을 사용하여 ceph Manager, Ceph Monitors, Ceph OSD, 모니터링 스택 등과 같은 데몬을 배포할 수 있습니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 모든 노드에 대한 루트 수준 액세스.

프로세스

yaml파일을 생성합니다.예제

[root@host01 ~]# touch mon.yaml

이 파일은 다음 두 가지 방법으로 구성할 수 있습니다.

배치 사양에 호스트 세부 정보를 포함하도록 파일을 편집합니다.

구문

service_type: SERVICE_NAME placement: hosts: - HOST_NAME_1 - HOST_NAME_2

예제

service_type: mon placement: hosts: - host01 - host02 - host03배치 사양에 레이블 세부 정보를 포함하도록 파일을 편집합니다.

구문

service_type: SERVICE_NAME placement: label: "LABEL_1"

예제

service_type: mon placement: label: "mon"

선택 사항: 서비스를 배포하는 동안 CPU, CA 인증서 및 기타 파일과 같은 서비스 사양 파일에서 추가 컨테이너 인수를 사용할 수도 있습니다.

예제

extra_container_args: - "-v" - "/etc/pki/ca-trust/extracted:/etc/pki/ca-trust/extracted:ro" - "--security-opt" - "label=disable" - "cpus=2" - "--collector.textfile.directory=/var/lib/node_exporter/textfile_collector2"

참고Red Hat Ceph Storage는 추가 인수를 사용하여 Cephadm에서 배포한 node-exporter에서 추가 지표를 활성화할 수 있습니다.

YAML 파일을 컨테이너의 디렉터리에 마운트합니다.

예제

[root@host01 ~]# cephadm shell --mount mon.yaml:/var/lib/ceph/mon/mon.yaml

디렉터리로 이동합니다.

예제

[ceph: root@host01 /]# cd /var/lib/ceph/mon/

서비스 사양을 사용하여 Ceph 데몬을 배포합니다.

구문

ceph orch apply -i FILE_NAME.yaml예제

[ceph: root@host01 mon]# ceph orch apply -i mon.yaml

검증

서비스를 나열합니다.

예제

[ceph: root@host01 /]# ceph orch ls

호스트, 데몬 및 프로세스를 나열합니다.

구문

ceph orch ps --daemon_type=DAEMON_NAME예제

[ceph: root@host01 /]# ceph orch ps --daemon_type=mon

추가 리소스

- Red Hat Ceph Storage 운영 가이드 의 Ceph Orchestrator 섹션을 사용하여 호스트 목록을 참조하십시오.

2.7. 서비스 사양을 사용하여 Ceph 파일 시스템 미러링 데몬 배포

Ceph 파일 시스템(CephFS)은 CephFS 미러링 데몬(cephfs-mirror)을 사용하여 원격 CephFS 파일 시스템에 대한 스냅샷의 비동기 복제를 지원합니다. 스냅샷 동기화는 스냅샷 데이터를 원격 CephFS에 복사하고 이름이 동일한 원격 대상에 새 스냅샷을 생성합니다. Ceph Orchestrator를 사용하여 YAML 파일의 서비스 사양을 사용하여 cephfs-mirror 를 배포할 수 있습니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 모든 노드에 대한 루트 수준 액세스.

- CephFS가 생성되었습니다.

프로세스

yaml파일을 생성합니다.예제

[root@host01 ~]# touch mirror.yaml

다음을 포함하도록 파일을 편집합니다.

구문

service_type: cephfs-mirror service_name: SERVICE_NAME placement: hosts: - HOST_NAME_1 - HOST_NAME_2 - HOST_NAME_3

예제

service_type: cephfs-mirror service_name: cephfs-mirror placement: hosts: - host01 - host02 - host03YAML 파일을 컨테이너의 디렉터리에 마운트합니다.

예제

[root@host01 ~]# cephadm shell --mount mirror.yaml:/var/lib/ceph/mirror.yaml

디렉터리로 이동합니다.

예제

[ceph: root@host01 /]# cd /var/lib/ceph/

서비스 사양을 사용하여

cephfs-mirror데몬을 배포합니다.예제

[ceph: root@host01 /]# ceph orch apply -i mirror.yaml

검증

서비스를 나열합니다.

예제

[ceph: root@host01 /]# ceph orch ls

호스트, 데몬 및 프로세스를 나열합니다.

예제

[ceph: root@host01 /]# ceph orch ps --daemon_type=cephfs-mirror

추가 리소스

-

cephfs-mirror데몬에 대한 자세한 내용은 Ceph 파일 시스템 미러를 참조하십시오.

3장. Ceph Orchestrator를 사용한 호스트 관리

스토리지 관리자는 백엔드에서 Cephadm과 함께 Ceph Orchestrator를 사용하여 기존 Red Hat Ceph Storage 클러스터에서 호스트를 추가, 나열, 제거할 수 있습니다.

호스트에 레이블을 추가할 수도 있습니다. 레이블은 자유형이며 특정 의미가 없습니다. 각 호스트에는 여러 개의 레이블이 있을 수 있습니다. 예를 들어, 모니터링 데몬이 배포된 모든 호스트에 mon 레이블을 적용하고, 관리자 데몬이 배포된 모든 호스트의 경우 mgr, Ceph 개체 게이트웨이의 경우 rgw 를 적용합니다.

스토리지 클러스터의 모든 호스트에 레이블을 지정하면 각 호스트에서 실행되는 데몬을 빠르게 식별할 수 있으므로 시스템 관리 작업을 단순화하는 데 도움이 됩니다. 또한 Ceph Orchestrator 또는 YAML 파일을 사용하여 특정 호스트 레이블이 있는 호스트에서 데몬을 배포하거나 제거할 수 있습니다.

이 섹션에서는 다음 관리 작업에 대해 설명합니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 모든 노드에 대한 루트 수준 액세스.

-

새 호스트의 IP 주소는

/etc/hosts파일에서 업데이트해야 합니다.

3.1. Ceph Orchestrator를 사용하여 호스트 추가

백엔드에서 Ceph Orchestrator를 Cephadm과 함께 사용하여 기존 Red Hat Ceph Storage 클러스터에 호스트를 추가할 수 있습니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 스토리지 클러스터의 모든 노드에 대한 루트 수준 액세스.

- 노드를 CDN에 등록하고 서브스크립션을 연결합니다.

-

sudo 및 암호 없이

ssh를 사용하는 Ansible 사용자는 스토리지 클러스터의 모든 노드에 액세스할 수 있습니다.

프로세스

Ceph 관리 노드에서 Cephadm 쉘에 로그인합니다.

예제

[root@host01 ~]# cephadm shell

클러스터의 공개 SSH 키를 폴더에 추출합니다.

구문

ceph cephadm get-pub-key > ~/PATH예제

[ceph: root@host01 /]# ceph cephadm get-pub-key > ~/ceph.pub

Ceph 클러스터의 공개 SSH 키를 새 호스트의 root 사용자의

authorized_keys파일에 복사합니다.구문

ssh-copy-id -f -i ~/PATH root@HOST_NAME_2

예제

[ceph: root@host01 /]# ssh-copy-id -f -i ~/ceph.pub root@host02

Ansible 관리 노드에서 새 호스트를 Ansible 인벤토리 파일에 추가합니다. 파일의 기본 위치는

/usr/share/cephadm-ansible/hosts입니다. 다음 예제는 일반적인 인벤토리 파일의 구조를 보여줍니다.예제

host01 host02 host03 [admin] host00

참고이전에 새 호스트를 Ansible 인벤토리 파일에 추가하고 호스트에서 preflight 플레이북을 실행한 경우 6 단계로 건너뜁니다.

--limit옵션을 사용하여 preflight 플레이북을 실행합니다.구문

ansible-playbook -i INVENTORY_FILE cephadm-preflight.yml --extra-vars "ceph_origin=rhcs" --limit NEWHOST

예제

[ceph-admin@admin cephadm-ansible]$ ansible-playbook -i hosts cephadm-preflight.yml --extra-vars "ceph_origin=rhcs" --limit host02

preflight Playbook은 새 호스트에

podman,lvm2,chronyd,cephadm을 설치합니다. 설치가 완료되면cephadm은/usr/sbin/디렉터리에 있습니다.Ceph 관리 노드에서 Cephadm 쉘에 로그인합니다.

예제

[root@host01 ~]# cephadm shell

cephadm오케스트레이터를 사용하여 스토리지 클러스터에 호스트를 추가합니다.구문

ceph orch host add HOST_NAME IP_ADDRESS_OF_HOST [--label=LABEL_NAME_1,LABEL_NAME_2]

--label옵션은 선택 사항이며, 이는 호스트를 추가할 때 레이블을 추가합니다. 호스트에 여러 레이블을 추가할 수 있습니다.예제

[ceph: root@host01 /]# ceph orch host add host02 10.10.128.70 --labels=mon,mgr

검증

호스트를 나열합니다.

예제

[ceph: root@host01 /]# ceph orch host ls

추가 리소스

- Red Hat Ceph Storage 운영 가이드 의 Ceph Orchestrator 섹션을 사용하여 호스트 목록을 참조하십시오.

-

cephadm-preflight플레이북에 대한 자세한 내용은 Red Hat Ceph Storage 설치 가이드 의 preflight 플레이북 실행 섹션을 참조하십시오. - Red Hat Ceph Storage 노드 등록 및 Red Hat Ceph Storage 설치 가이드의 서브스크립션 연결 섹션을 참조하십시오.

- Red Hat Ceph Storage 설치 가이드의 sudo 액세스 권한이 있는 Ansible 사용자 생성 섹션을 참조하십시오.

3.2. Ceph Orchestrator를 사용하여 여러 호스트 추가

Ceph Orchestrator를 사용하여 YAML 파일 형식의 서비스 사양을 사용하여 동시에 Red Hat Ceph Storage 클러스터에 여러 호스트를 추가할 수 있습니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

프로세스

hosts.yaml파일을 생성합니다.예제

[root@host01 ~]# touch hosts.yaml

다음 세부 정보를 포함하도록

hosts.yaml파일을 편집합니다.예제

service_type: host addr: host01 hostname: host01 labels: - mon - osd - mgr --- service_type: host addr: host02 hostname: host02 labels: - mon - osd - mgr --- service_type: host addr: host03 hostname: host03 labels: - mon - osd

YAML 파일을 컨테이너의 디렉터리에 마운트합니다.

예제

[root@host01 ~]# cephadm shell --mount hosts.yaml:/var/lib/ceph/hosts.yaml

디렉터리로 이동합니다.

예제

[ceph: root@host01 /]# cd /var/lib/ceph/

서비스 사양을 사용하여 호스트를 배포합니다.

구문

ceph orch apply -i FILE_NAME.yaml예제

[ceph: root@host01 hosts]# ceph orch apply -i hosts.yaml

검증

호스트를 나열합니다.

예제

[ceph: root@host01 /]# ceph orch host ls

추가 리소스

- Red Hat Ceph Storage 운영 가이드 의 Ceph Orchestrator 섹션을 사용하여 호스트 목록을 참조하십시오.

3.3. Ceph Orchestrator를 사용하여 호스트 나열

Ceph Orchestrators를 사용하여 Ceph 클러스터의 호스트를 나열할 수 있습니다.

ceph orch host ls 명령의 출력에서 호스트 STATUS가 비어 있습니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 호스트는 스토리지 클러스터에 추가됩니다.

프로세스

Cephadm 쉘에 로그인합니다.

예제

[root@host01 ~]# cephadm shell

클러스터 호스트를 나열합니다.

예제

[ceph: root@host01 /]# ceph orch host ls

예상되는 호스트의 STATUS 가 비어 있음을 확인할 수 있습니다.

3.4. 호스트에 레이블 추가

Ceph Orchestrator를 사용하여 호스트에 레이블을 추가합니다. 레이블을 사용하여 데몬 배치를 지정할 수 있습니다.

레이블의 몇 가지 예는 호스트에 배포된 서비스를 기반으로 하는 mgr,mon, osd 입니다. 각 호스트에는 여러 개의 레이블이 있을 수 있습니다.

cephadm 에 특별한 의미가 있고 _ 로 시작하는 다음 호스트 레이블을 추가할 수도 있습니다.

-

_no_schedule: 이 레이블은cephadm이 호스트에 데몬을 예약하거나 배포하지 못하도록 합니다. Ceph 데몬이 이미 포함된 기존 호스트에 추가된 경우cephadm은 자동으로 제거되지 않은 OSD를 제외하고 해당 데몬을 다른 위치에서 이동합니다._no_schedule레이블을 사용하여 호스트를 추가하면 데몬이 배포되지 않습니다. 호스트가 제거되기 전에 데몬이 드레이닝되면 해당 호스트에_no_schedule레이블이 설정됩니다. -

_no_autotune_memory:이 레이블은 호스트에서 메모리를 자동 조정하지 않습니다. 해당 호스트에서 하나 이상의 데몬에 대해osd_memory_target_autotune옵션 또는 기타 유사한 옵션이 활성화된 경우에도 데몬 메모리가 튜닝되지 않습니다. -

_admin: 기본적으로_admin레이블은 스토리지 클러스터의 부트스트랩 호스트에 적용되며client.admin키는ceph orch 클라이언트 키링 {ls|set|rm}함수를 사용하여 해당 호스트에 배포되도록 설정됩니다. 일반적으로 이 레이블을 추가 호스트에 추가하면cephadm이/etc/ceph디렉터리에 구성 및 키링 파일을 배포합니다.

사전 요구 사항

- 설치 및 부트스트랩된 스토리지 클러스터입니다.

- 스토리지 클러스터의 모든 노드에 대한 루트 수준 액세스.

- 호스트는 스토리지 클러스터에 추가됩니다.

프로세스

Cephadm 쉘에 로그인합니다.

예제

[root@host01 ~]# cephadm shell

호스트에 레이블을 추가합니다.

구문

ceph orch host label add HOSTNAME LABEL

예제

[ceph: root@host01 /]# ceph orch host label add host02 mon

검증

호스트를 나열합니다.

예제

[ceph: root@host01 /]# ceph orch host ls

3.5. 호스트에서 레이블 제거

Ceph 오케스트레이터를 사용하여 호스트에서 레이블을 제거할 수 있습니다.

사전 요구 사항

- 설치 및 부트스트랩된 스토리지 클러스터입니다.

- 스토리지 클러스터의 모든 노드에 대한 루트 수준 액세스.

프로세스

cephadm쉘을 시작합니다.[root@host01 ~]# cephadm shell [ceph: root@host01 /]#

레이블을 제거합니다.

구문

ceph orch host label rm HOSTNAME LABEL

예제

[ceph: root@host01 /]# ceph orch host label rm host02 mon

검증

호스트를 나열합니다.

예제

[ceph: root@host01 /]# ceph orch host ls

3.6. Ceph Orchestrator를 사용하여 호스트 제거

Ceph Orchestrators로 Ceph 클러스터의 호스트를 제거할 수 있습니다. 모든 데몬은 작업이 완료될 때까지 데몬 또는 클러스터를 배포할 수 없도록 _no_schedule 레이블을 추가하는 drain 옵션으로 제거됩니다.

부트스트랩 호스트를 제거하는 경우 호스트를 제거하기 전에 관리자 인증 키와 구성 파일을 스토리지 클러스터의 다른 호스트에 복사해야 합니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 모든 노드에 대한 루트 수준 액세스.

- 호스트는 스토리지 클러스터에 추가됩니다.

- 모든 서비스가 배포됩니다.

- Cephadm은 서비스를 제거해야 하는 노드에 배포됩니다.

프로세스

Cephadm 쉘에 로그인합니다.

예제

[root@host01 ~]# cephadm shell

호스트 세부 정보를 가져옵니다.

예제

[ceph: root@host01 /]# ceph orch host ls

호스트의 모든 데몬을 드레이닝합니다.

구문

ceph orch host drain HOSTNAME예제

[ceph: root@host01 /]# ceph orch host drain host02

_no_schedule레이블은 배포를 차단하는 호스트에 자동으로 적용됩니다.OSD 제거 상태를 확인합니다.

예제

[ceph: root@host01 /]# ceph orch osd rm status

OSD에 배치 그룹(PG)이 없는 경우 스토리지 클러스터에서 OSD가 해제되어 제거됩니다.

스토리지 클러스터에서 모든 데몬이 제거되었는지 확인합니다.

구문

ceph orch ps HOSTNAME예제

[ceph: root@host01 /]# ceph orch ps host02

호스트를 제거합니다.

구문

ceph orch host rm HOSTNAME예제

[ceph: root@host01 /]# ceph orch host rm host02

추가 리소스

- 자세한 내용은 Red Hat Ceph Storage Operations Guide의 Ceph Orchestrator 섹션을 참조하십시오.

- 자세한 내용은 Red Hat Ceph Storage Operations Guide의 Ceph Orchestrator 섹션을 참조하십시오.

3.7. Ceph Orchestrator를 사용하여 호스트를 유지 관리 모드에 배치

Ceph Orchestrator를 사용하여 호스트를 유지 관리 모드로 배치할 수 있습니다. ceph orch host maintenance enter 명령은 systemd 대상 을 중지하여 모든 Ceph 데몬이 호스트에서 중지되도록 합니다. 마찬가지로 ceph orch host maintenance exit 명령은 systemd 대상 을 재시작하고 Ceph 데몬은 자체적으로 다시 시작됩니다.

오케스트레이터는 호스트가 유지보수 모드에 배치될 때 다음 워크플로우를 채택합니다.

-

호스트를 제거해도

orch host ok-to-stop명령을 실행하여 데이터 가용성에 영향을 미치지 않는지 확인합니다. -

호스트에 Ceph OSD 데몬이 있는 경우

noout을 host 하위 트리에 적용하여 계획된 유지 관리 슬롯 중에 데이터 마이그레이션이 트리거되지 않도록 합니다. - Ceph 대상을 중지하여 모든 데몬을 중지합니다.

-

재부팅이 Ceph 서비스를 자동으로 시작하지 않도록 호스트에서

ceph 대상을 비활성화합니다.

유지 관리를 종료하면 위의 시퀀스가 되돌아갑니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 모든 노드에 대한 루트 수준 액세스.

- 클러스터에 추가된 호스트입니다.

프로세스

Cephadm 쉘에 로그인합니다.

예제

[root@host01 ~]# cephadm shell

호스트를 유지 관리 모드로 배치하거나 유지 관리 모드에서 호스트를 배치할 수 있습니다.

호스트를 유지 관리 모드로 설정합니다.

구문

ceph orch host maintenance enter HOST_NAME [--force]예제

[ceph: root@host01 /]# ceph orch host maintenance enter host02 --force

--force플래그를 사용하면 경고를 바이패스할 수 있지만 경고를 바이패스할 수 없습니다.호스트를 유지 관리 모드에서 해제합니다.

구문

ceph orch host maintenance exit HOST_NAME예제

[ceph: root@host01 /]# ceph orch host maintenance exit host02

검증

호스트를 나열합니다.

예제

[ceph: root@host01 /]# ceph orch host ls

4장. Ceph Orchestrator를 사용한 모니터 관리

스토리지 관리자는 배치 사양을 사용하여 추가 모니터를 배포하고, 서비스 사양을 사용하여 모니터를 추가하고, 서브넷 구성에 모니터를 추가하고, 특정 호스트에 모니터를 추가할 수 있습니다. 이 외에도 Ceph Orchestrator를 사용하여 모니터를 제거할 수 있습니다.

기본적으로 일반적인 Red Hat Ceph Storage 클러스터에는 서로 다른 호스트에 배포된 모니터 데몬이 3개 또는 5개입니다.

클러스터에 5개 이상의 노드가 있는 경우 5개의 모니터를 배포하는 것이 좋습니다.

Ceph가 OSP director와 함께 배포될 때 세 개의 모니터를 배포하는 것이 좋습니다.

Ceph는 클러스터가 증가할 때 모니터 데몬을 자동으로 배포하고 클러스터가 축소되면 모니터 데몬을 자동으로 확장합니다. 이러한 자동 증가 및 축소의 원활한 실행은 적절한 서브넷 구성에 따라 달라집니다.

모니터 노드 또는 전체 클러스터가 단일 서브넷에 있는 경우 클러스터에 새 호스트를 추가할 때 Cephadm에서 최대 5개의 모니터 데몬을 자동으로 추가합니다. cephadm 은 새 호스트에서 모니터 데몬을 자동으로 구성합니다. 새 호스트는 스토리지 클러스터의 부트스트랩 호스트와 동일한 서브넷에 있습니다.

cephadm 은 스토리지 클러스터 크기의 변경 사항에 맞게 모니터를 배포 및 확장할 수도 있습니다.

4.1. Ceph Monitors

Ceph Monitor는 스토리지 클러스터 맵의 마스터 복사본을 유지 관리하는 경량 프로세스입니다. 모든 Ceph 클라이언트는 Ceph 모니터에 연락하여 스토리지 클러스터 맵의 현재 사본을 검색하여 클라이언트가 풀에 바인딩하고 데이터를 읽고 쓸 수 있습니다.

Ceph Monitor는 Paxos 프로토콜의 변형을 사용하여 스토리지 클러스터 전체의 맵 및 기타 중요한 정보에 대한 합의를 설정합니다. Ceph는 Paxos의 특성으로 인해 쿼럼을 구축하기 위해 대부분의 모니터가 실행 중이어야 하므로 합의를 설정해야합니다.

Red Hat은 프로덕션 클러스터에 대한 지원을 받으려면 별도의 호스트에 3개 이상의 모니터가 필요합니다.

홀수의 모니터를 배포하는 것이 좋습니다. 홀수의 Ceph 모니터는 짝수의 모니터보다 실패에 대한 복원력이 높습니다. 예를 들어 2개의 모니터 배포에서 쿼럼을 유지하기 위해 Ceph는 3개의 모니터를 사용할 수 없습니다. 4개의 모니터가 1개, 하나의 실패, 5개의 모니터, 두 개의 실패가 있습니다. 이 때문에 홀수가 권장됩니다. 요약하면 Ceph는 대부분의 모니터를 실행하고 서로 통신할 수 있어야 하며 3개 중 3개, 4개 중 3개 등이어야 합니다.

멀티 노드 Ceph 스토리지 클러스터를 처음 배포하기 위해 모니터 3개가 필요하므로 모니터가 3개 이상 필요한 경우 한 번에 2개를 늘리십시오.

Ceph 모니터는 경량이므로 OpenStack 노드와 동일한 호스트에서 실행할 수 있습니다. 그러나 Red Hat은 별도의 호스트에서 모니터를 실행하는 것이 좋습니다.

Red Hat은 컨테이너화된 환경에서 Ceph 서비스 배치만 지원합니다.

스토리지 클러스터에서 모니터를 제거할 때 Ceph Monitor가 Paxos 프로토콜을 사용하여 마스터 스토리지 클러스터 맵에 대한 합의를 설정하는 것이 좋습니다. 쿼럼을 설정하려면 충분한 수의 Ceph 모니터가 있어야 합니다.

추가 리소스

- 지원되는 모든 Ceph 구성은 Red Hat Ceph Storage 지원 구성 지식베이스 문서를 참조하십시오.

4.2. 모니터 선택 전략 구성

모니터 선택 전략은 네트워크 분할을 식별하고 오류를 처리합니다. 선택 모니터 전략을 세 가지 모드로 구성할 수 있습니다.

-

클래식- 가장 낮은 순위의 모니터가 두 사이트 간의 선택 모듈을 기반으로 하는 기본 모드입니다. -

허용하지않음 - 이 모드를 사용하면 모니터를 허용하지 않음으로 표시할 수 있으며, 이 모드에서는 쿼럼에 참여하고 클라이언트를 서비스하지만 선택한 리더가 될 수 없습니다. 이를 통해 허용하지 않는 리더 목록에 모니터를 추가할 수 있습니다. 모니터가 허용되지 않는 목록에 있는 경우 항상 다른 모니터로 지연됩니다. -

연결- 이 모드는 주로 네트워크 불일치를 확인하는 데 사용됩니다. 각 모니터에서 피어에 대해 제공하는 활성 상태를 확인하고 가장 연결되고 신뢰할 수 있는 모니터를 리더가 되도록 선택하는 ping을 기반으로 연결 점수를 평가합니다. 이 모드는 네트워크 분할을 처리하도록 설계되었으며, 클러스터가 여러 데이터 센터 간에 확장되거나 영향을 받을 수 있는 경우 발생할 수 있습니다. 이 모드는 연결 점수 등급을 통합하고 모니터를 최상의 점수로 선택합니다. 특정 모니터가 리더가 되도록 하려면 특정 모니터가 목록의 첫 번째 모니터가0인 첫 번째 모니터가 되도록 선택 전략을 구성합니다.

다른 모드에서 기능이 필요하지 않는 한 클래식 모드를 사용하는 것이 좋습니다.

클러스터를 구성하기 전에 다음 명령에서 election_strategy 를 클래식,허용하지 않음 또는 연결을 변경합니다.

구문

ceph mon set election_strategy {classic|disallow|connectivity}

4.3. 명령줄 인터페이스를 사용하여 Ceph 모니터 데몬 배포

Ceph Orchestrator는 기본적으로 하나의 모니터 데몬을 배포합니다. 명령줄 인터페이스에서 배치 사양을 사용하여 추가 모니터 데몬을 배포할 수 있습니다. 다른 수의 모니터 데몬을 배포하려면 다른 수를 지정합니다. 모니터 데몬을 배포해야 하는 호스트를 지정하지 않으면 Ceph Orchestrator에서 호스트를 무작위로 선택하고 모니터 데몬을 배포합니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 호스트가 클러스터에 추가됩니다.

프로세스

Cephadm 쉘에 로그인합니다.

예제

[root@host01 ~]# cephadm shell

- Ceph 모니터 데몬을 배포하는 방법은 다음 네 가지가 있습니다.

방법 1

배치 사양을 사용하여 호스트에 모니터를 배포합니다.

참고--placement옵션을 사용하여 특정 호스트에 배포하는 것이 좋습니다.구문

ceph orch apply mon --placement="HOST_NAME_1 HOST_NAME_2 HOST_NAME_3"

예제

[ceph: root@host01 /]# ceph orch apply mon --placement="host01 host02 host03"

참고명령에서 부트스트랩 노드를 첫 번째 노드로 포함해야 합니다.

중요ceph orch apply monreplaceses로 모니터를 개별적으로 추가하지 말고 모든 호스트에 모니터를 추가하지 않습니다. 예를 들어 다음 명령을 실행하는 경우 첫 번째 명령은host01에 모니터를 생성합니다. 그런 다음 두 번째 명령은 host1의 모니터를 대체하고host02에서 모니터를 생성합니다. 그런 다음 세 번째 명령은host02의 모니터를 대체하고host03에서 모니터를 생성합니다. 결국 세 번째 호스트에만 모니터가 있습니다.# ceph orch apply mon host01 # ceph orch apply mon host02 # ceph orch apply mon host03

방법 2

배치 사양을 사용하여 라벨이 있는 특정 호스트에 특정 모니터 수를 배포합니다.

호스트에 레이블을 추가합니다.

구문

ceph orch host label add HOSTNAME_1 LABEL

예제

[ceph: root@host01 /]# ceph orch host label add host01 mon

데몬을 배포합니다.

구문

ceph orch apply mon --placement="HOST_NAME_1:mon HOST_NAME_2:mon HOST_NAME_3:mon"

예제

[ceph: root@host01 /]# ceph orch apply mon --placement="host01:mon host02:mon host03:mon"

방법 3

배치 사양을 사용하여 특정 호스트에 특정 모니터 수를 배포합니다.

구문

ceph orch apply mon --placement="NUMBER_OF_DAEMONS HOST_NAME_1 HOST_NAME_2 HOST_NAME_3"

예제

[ceph: root@host01 /]# ceph orch apply mon --placement="3 host01 host02 host03"

방법 4

스토리지 클러스터의 호스트에 모니터 데몬을 임의로 배포합니다.

구문

ceph orch apply mon NUMBER_OF_DAEMONS예제

[ceph: root@host01 /]# ceph orch apply mon 3

검증

서비스를 나열합니다.

예제

[ceph: root@host01 /]# ceph orch ls

호스트, 데몬 및 프로세스를 나열합니다.

구문

ceph orch ps --daemon_type=DAEMON_NAME예제

[ceph: root@host01 /]# ceph orch ps --daemon_type=mon

4.4. 서비스 사양을 사용하여 Ceph 모니터 데몬 배포

Ceph Orchestrator는 기본적으로 하나의 모니터 데몬을 배포합니다. YAML 형식 파일과 같이 서비스 사양을 사용하여 추가 모니터 데몬을 배포할 수 있습니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 호스트가 클러스터에 추가됩니다.

프로세스

mon.yaml파일을 생성합니다.예제

[root@host01 ~]# touch mon.yaml

다음 세부 정보를 포함하도록

mon.yaml파일을 편집합니다.구문

service_type: mon placement: hosts: - HOST_NAME_1 - HOST_NAME_2예제

service_type: mon placement: hosts: - host01 - host02YAML 파일을 컨테이너의 디렉터리에 마운트합니다.

예제

[root@host01 ~]# cephadm shell --mount mon.yaml:/var/lib/ceph/mon/mon.yaml

디렉터리로 이동합니다.

예제

[ceph: root@host01 /]# cd /var/lib/ceph/mon/

모니터 데몬을 배포합니다.

구문

ceph orch apply -i FILE_NAME.yaml예제

[ceph: root@host01 mon]# ceph orch apply -i mon.yaml

검증

서비스를 나열합니다.

예제

[ceph: root@host01 /]# ceph orch ls

호스트, 데몬 및 프로세스를 나열합니다.

구문

ceph orch ps --daemon_type=DAEMON_NAME예제

[ceph: root@host01 /]# ceph orch ps --daemon_type=mon

4.5. Ceph Orchestrator를 사용하여 특정 네트워크에 모니터 데몬 배포

Ceph Orchestrator는 기본적으로 하나의 모니터 데몬을 배포합니다. 각 모니터의 IP 주소 또는 CIDR 네트워크를 명시적으로 지정하고 각 모니터가 배치되는 위치를 제어할 수 있습니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 호스트가 클러스터에 추가됩니다.

프로세스

Cephadm 쉘에 로그인합니다.

예제

[root@host01 ~]# cephadm shell

자동화된 모니터 배포를 비활성화합니다.

예제

[ceph: root@host01 /]# ceph orch apply mon --unmanaged

특정 네트워크의 호스트에 모니터를 배포합니다.

구문

ceph orch daemon add mon HOST_NAME_1:IP_OR_NETWORK

예제

[ceph: root@host01 /]# ceph orch daemon add mon host03:10.1.2.123

검증

서비스를 나열합니다.

예제

[ceph: root@host01 /]# ceph orch ls

호스트, 데몬 및 프로세스를 나열합니다.

구문

ceph orch ps --daemon_type=DAEMON_NAME예제

[ceph: root@host01 /]# ceph orch ps --daemon_type=mon

4.6. Ceph Orchestrator를 사용하여 모니터 데몬 제거

호스트에서 모니터 데몬을 제거하려면 다른 호스트에 모니터 데몬을 다시 배포할 수 있습니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 호스트가 클러스터에 추가됩니다.

- 호스트에 배포된 하나 이상의 모니터 데몬.

프로세스

Cephadm 쉘에 로그인합니다.

예제

[root@host01 ~]# cephadm shell

ceph orch apply명령을 실행하여 필요한 모니터 데몬을 배포합니다.구문

ceph orch apply mon “NUMBER_OF_DAEMONS HOST_NAME_1 HOST_NAME_3”

host02에서 모니터 데몬을 제거하려면 다른 호스트에 모니터를 재배포할 수 있습니다.예제

[ceph: root@host01 /]# ceph orch apply mon “2 host01 host03”

검증

호스트,daemon 및 프로세스를 나열합니다.

구문

ceph orch ps --daemon_type=DAEMON_NAME예제

[ceph: root@host01 /]# ceph orch ps --daemon_type=mon

4.7. 비정상 스토리지 클러스터에서 Ceph Monitor 제거

비정상 스토리지 클러스터에서 ceph-mon 데몬을 제거할 수 있습니다. 비정상 스토리지 클러스터는 배치 그룹이 active + clean 상태가 아닌 영구적으로 있는 클러스터입니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- Ceph Monitor 노드에 대한 루트 수준 액세스.

- 하나 이상의 Ceph Monitor 노드를 실행합니다.

프로세스

남아 있는 모니터를 식별하고 호스트에 로그인합니다.

구문

ssh root@MONITOR_ID예제

[root@admin ~]# ssh root@host00

각 Ceph Monitor 호스트에 로그인하고 모든 Ceph 모니터를 중지합니다.

구문

cephadm unit --name DAEMON_NAME.HOSTNAME stop

예제

[root@host00 ~]# cephadm unit --name mon.host00 stop

확장된 데몬 유지 관리에 적합한 환경을 설정하고 데몬을 대화형으로 실행하려면 다음을 수행합니다.

구문

cephadm shell --name DAEMON_NAME.HOSTNAME

예제

[root@host00 ~]# cephadm shell --name mon.host00

monmap파일의 사본을 추출합니다.구문

ceph-mon -i HOSTNAME --extract-monmap TEMP_PATH

예제

[ceph: root@host00 /]# ceph-mon -i host01 --extract-monmap /tmp/monmap 2022-01-05T11:13:24.440+0000 7f7603bd1700 -1 wrote monmap to /tmp/monmap

비활성화되지 않은 Ceph 모니터를 제거합니다.

구문

monmaptool TEMPORARY_PATH --rm HOSTNAME

예제

[ceph: root@host00 /]# monmaptool /tmp/monmap --rm host01

제거된 모니터가 있는 남아 있는 모니터 맵을 Ceph 모니터에 삽입합니다.

구문

ceph-mon -i HOSTNAME --inject-monmap TEMP_PATH

예제

[ceph: root@host00 /]# ceph-mon -i host00 --inject-monmap /tmp/monmap

남아 있는 모니터만 시작합니다.

구문

cephadm unit --name DAEMON_NAME.HOSTNAME start

예제

[root@host00 ~]# cephadm unit --name mon.host00 start

모니터가 쿼럼을 형성하는지 확인합니다.

예제

[ceph: root@host00 /]# ceph -s

-

선택 사항: 제거된 Ceph Monitor의 데이터 디렉토리를

/var/lib/ceph/CLUSTER_FSID/mon.HOSTNAME디렉터리에 보관합니다.

5장. Ceph Orchestrator를 사용한 관리자 관리

스토리지 관리자는 Ceph Orchestrator를 사용하여 추가 관리자 데몬을 배포할 수 있습니다. cephadm 은 부트스트랩 프로세스 중에 부트스트랩 노드에 관리자 데몬을 자동으로 설치합니다.

일반적으로 동일한 수준의 가용성을 달성하려면 Ceph Monitor 데몬을 실행하는 각 호스트에 Ceph Manager를 설정해야 합니다.

기본적으로 ceph-mgr 인스턴스가 먼저 제공되는 것은 Ceph 모니터에 의해 활성화되며 다른 인스턴스는 대기 관리자입니다. ceph-mgr 데몬 사이에 쿼럼이 없어야 합니다.

활성 데몬이 mon mgr 비컨 유예보다 더 많은 모니터에 비컨 을 보내는 데 실패하면 대기 상태로 교체됩니다.

장애 조치를 사전 시도하려면 ceph mgr fail MANAGER_NAME 명령으로 ceph-mgr 데몬을 실패로 명시적으로 표시할 수 있습니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 모든 노드에 대한 루트 수준 액세스.

- 호스트가 클러스터에 추가됩니다.

5.1. Ceph Orchestrator를 사용하여 관리자 데몬 배포

Ceph Orchestrator는 기본적으로 두 개의 Manager 데몬을 배포합니다. 명령줄 인터페이스에서 배치 사양을 사용하여 추가 관리자 데몬을 배포할 수 있습니다. 다른 수의 Manager 데몬을 배포하려면 다른 수를 지정합니다. Manager 데몬을 배포해야 하는 호스트를 지정하지 않으면 Ceph Orchestrator에서 호스트를 무작위로 선택하고 Manager 데몬을 배포합니다.

배포마다 배포마다 3개 이상의 Ceph Manager가 있는지 확인합니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 호스트가 클러스터에 추가됩니다.

프로세스

Cephadm 쉘에 로그인합니다.

예제

[root@host01 ~]# cephadm shell

- 관리자 데몬은 다음 두 가지 방법으로 배포할 수 있습니다.

방법 1

특정 호스트 세트에 배치 사양을 사용하여 관리자 데몬을 배포합니다.

참고--placement옵션을 사용하여 특정 호스트에 배포하는 것이 좋습니다.구문

ceph orch apply mgr --placement=" HOST_NAME_1 HOST_NAME_2 HOST_NAME_3"

예제

[ceph: root@host01 /]# ceph orch apply mgr --placement="host01 host02 host03"

방법 2

스토리지 클러스터의 호스트에 관리자 데몬을 임의로 배포합니다.

구문

ceph orch apply mgr NUMBER_OF_DAEMONS예제

[ceph: root@host01 /]# ceph orch apply mgr 3

검증

서비스를 나열합니다.

예제

[ceph: root@host01 /]# ceph orch ls

호스트, 데몬 및 프로세스를 나열합니다.

구문

ceph orch ps --daemon_type=DAEMON_NAME예제

[ceph: root@host01 /]# ceph orch ps --daemon_type=mgr

5.2. Ceph Orchestrator를 사용하여 관리자 데몬 제거

호스트에서 관리자 데몬을 제거하려면 다른 호스트에 데몬을 다시 배포할 수 있습니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 모든 노드에 대한 루트 수준 액세스.

- 호스트가 클러스터에 추가됩니다.

- 호스트에 배포된 하나 이상의 관리자 데몬.

프로세스

Cephadm 쉘에 로그인합니다.

예제

[root@host01 ~]# cephadm shell

ceph orch apply명령을 실행하여 필요한 관리자 데몬을 재배포합니다.구문

ceph orch apply mgr "NUMBER_OF_DAEMONS HOST_NAME_1 HOST_NAME_3"

host02에서 관리자 데몬을 제거하려면 다른 호스트에 manager 데몬을 재배포할 수 있습니다.예제

[ceph: root@host01 /]# ceph orch apply mgr "2 host01 host03"

검증

호스트,daemon 및 프로세스를 나열합니다.

구문

ceph orch ps --daemon_type=DAEMON_NAME예제

[ceph: root@host01 /]# ceph orch ps --daemon_type=mgr

추가 리소스

5.3. Ceph Manager 모듈 사용

ceph mgr module ls 명령을 사용하여 사용 가능한 모듈과 현재 활성화된 모듈을 확인합니다.

ceph mgr 모듈을 사용하여 모듈을 활성화하거나 비활성화하면 MODULE 명령 또는 ceph mgr 모듈이 각각 MODULE 명령을 비활성화합니다.

모듈이 활성화되면 활성 ceph-mgr 데몬이 로드되어 실행합니다. HTTP 서버와 같은 서비스를 제공하는 모듈의 경우 모듈은 로드될 때 해당 주소를 게시할 수 있습니다. 이러한 모듈의 주소를 보려면 ceph mgr services 명령을 실행합니다.

일부 모듈은 대기 ceph-mgr 데몬과 활성 데몬에서 실행되는 특수 대기 모드를 구현할 수도 있습니다. 이를 통해 클라이언트가 대기 모드에 연결을 시도하는 경우 서비스를 제공하여 클라이언트를 활성 데몬으로 리디렉션할 수 있습니다.

다음은 dashboard 모듈을 활성화하는 예입니다.

[ceph: root@host01 /]# ceph mgr module enable dashboard

[ceph: root@host01 /]# ceph mgr module ls

MODULE

balancer on (always on)

crash on (always on)

devicehealth on (always on)

orchestrator on (always on)

pg_autoscaler on (always on)

progress on (always on)

rbd_support on (always on)

status on (always on)

telemetry on (always on)

volumes on (always on)

cephadm on

dashboard on

iostat on

nfs on

prometheus on

restful on

alerts -

diskprediction_local -

influx -

insights -

k8sevents -

localpool -

mds_autoscaler -

mirroring -

osd_perf_query -

osd_support -

rgw -

rook -

selftest -

snap_schedule -

stats -

telegraf -

test_orchestrator -

zabbix -

[ceph: root@host01 /]# ceph mgr services

{

"dashboard": "http://myserver.com:7789/",

"restful": "https://myserver.com:8789/"

}

클러스터가 처음 시작될 때 mgr_initial_modules 설정을 사용하여 활성화할 모듈을 재정의합니다. 그러나 이 설정은 클러스터의 나머지 수명 동안 무시됩니다. 부트 스트랩에만 사용합니다. 예를 들어 모니터 데몬을 처음 시작하기 전에 다음과 같은 섹션을 ceph.conf 파일에 추가할 수 있습니다.

[mon]

mgr initial modules = dashboard balancer모듈이 주석 행 후크를 구현하는 경우 일반 Ceph 명령으로 명령에 액세스할 수 있으며 Ceph는 모듈 명령을 표준 CLI 인터페이스에 자동으로 통합하고 모듈에 적절하게 라우팅합니다.

[ceph: root@host01 /]# ceph <command | help>

위의 명령과 함께 다음 구성 매개변수를 사용할 수 있습니다.

표 5.1. 구성 매개변수

| 설정 | 설명 | 유형 | 기본 |

|---|---|---|---|

|

| 에서 모듈 로드 경로입니다. | 문자열 |

|

|

| 데몬 데이터를 로드하는 경로(예: 인증) | 문자열 |

|

|

| 관리자 비컨과 기타 주기적 검사 사이의 시간(초)입니다. | 정수 |

|

|

| 마지막 비컨 이후 관리자가 실패한 것으로 간주해야 하는 기간이 얼마나 됩니까. | 정수 |

|

5.4. Ceph Manager balancer 모듈 사용

밸런서는 자동으로 또는 숙련된 방식으로 분산 배포를 수행하기 위해 OSD에서 배치 그룹(PG) 배치를 최적화하는 Ceph Manager(ceph-mgr)용 모듈입니다.

현재 balancer 모듈은 비활성화할 수 없습니다. 구성을 사용자 지정하도록만 해제할 수 있습니다.

모드

현재 두 가지 지원되는 밸런서 모드가 있습니다.

crush-compat: CRUSH 호환 모드는 Ceph Luminous에 도입된 compat

weight-set기능을 사용하여 CRUSH 계층 구조의 장치에 대한 대체 가중치 세트를 관리합니다. 일반 가중치는 장치에 저장하려는 대상 데이터 양을 반영하도록 장치의 크기로 설정되어야 합니다. 그런 다음 밸런서는 가능한 한 가깝게 대상 배포와 일치하는 배포를 달성하기 위해weight-set값을 최적화하여 작은 증분으로 조정하거나 축소합니다. PG 배치는 의사 임의 프로세스이므로 배치에는 자연적인 변형이 있습니다. 가중치를 최적화함으로써 밸런서는 이러한 자연적 변형을 수행합니다.이 모드는 이전 클라이언트와 완전히 호환됩니다. OSDMap 및 CRUSH 맵이 이전 클라이언트와 공유되면 밸런서는 최적화된 가중치를 실제 가중치로 제공합니다.

이 모드의 기본 제한은 계층 구조의 하위 트리가 모든 OSD를 공유하는 경우 다양한 배치 규칙으로 여러 CRUSH 계층 구조를 처리할 수 없다는 것입니다. 이 구성을 사용하면 공유 OSD에서 공간 사용률을 관리하기가 어렵기 때문에 일반적으로 사용하지 않는 것이 좋습니다. 따라서 이 제한은 일반적으로 문제가 아닙니다.

upmap: Luminous를 사용하여 시작하여 OSDMap은 일반 CRUSH 배치 계산에 예외적으로 개별 OSD에 대한 명시적 매핑을 저장할 수 있습니다. 이러한

upmap항목은 PG 매핑에 대한 세분화된 제어를 제공합니다. 이 CRUSH 모드는 분산 배포를 수행하기 위해 개별 PG의 배치를 최적화합니다. 대부분의 경우 이 배포는 균등하게 분배되지 않을 수 있으므로 각 OSD +/-1 PG에 동일한 수의 PG가 있는 "perfect"입니다.중요이 기능을 사용하려면 다음 명령을 사용하여 고급 또는 이후 클라이언트만 지원해야 함을 클러스터에 알려야 합니다.

[ceph: root@host01 /]# ceph osd set-require-min-compat-client luminous

기존 클라이언트 또는 데몬이 모니터에 연결되어 있으면 이 명령이 실패합니다.

알려진 문제로 인해 커널 CephFS 클라이언트는 자신을 jewel 클라이언트로 보고합니다. 이 문제를 해결하려면

--yes-i-really-mean-it플래그를 사용합니다.[ceph: root@host01 /]# ceph osd set-require-min-compat-client luminous --yes-i-really-mean-it

다음과 함께 사용 중인 클라이언트 버전을 확인할 수 있습니다.

[ceph: root@host01 /]# ceph features

5.4.1. 용량 밸런서를 사용하여 Red Hat Ceph 클러스터 밸런싱

용량 밸런서를 사용하여 Red Hat Ceph 스토리지 클러스터의 균형을 조정합니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

프로세스

balancer 모듈이 활성화되어 있는지 확인합니다.

예제

[ceph: root@host01 /]# ceph mgr module enable balancer

balancer 모듈을 활성화합니다.

예제

[ceph: root@host01 /]# ceph balancer on

모드를 변경하려면 다음 명령을 사용합니다. 기본 모드는

upmap입니다.예제

[ceph: root@host01 /]# ceph balancer mode crush-compat

또는

예제

[ceph: root@host01 /]# ceph balancer mode upmap

밸런서의 현재 상태를 확인합니다.

예제

[ceph: root@host01 /]# ceph balancer status

자동 밸런싱

기본적으로 balancer 모듈을 켜면 자동 밸런싱이 사용됩니다.

예제

[ceph: root@host01 /]# ceph balancer on

다음을 사용하여 밸런서를 다시 끌 수 있습니다.

예제

[ceph: root@host01 /]# ceph balancer off

이렇게 하면 이전 클라이언트와 이전 버전과 호환되는 crush-compat 모드를 사용하며 OSD가 동일하게 활용되도록 시간이 지남에 따라 데이터 배포를 약간 변경합니다.

제한

OSD가 실패하고 시스템이 아직 복구되지 않은 경우 클러스터의 성능이 저하된 경우 PG 배포에 대한 조정이 이루어지지 않습니다.

클러스터가 정상이면 밸런서는 변경 사항을 제한하여 잘못 배치되거나 이동해야 하는 PG의 백분율이 기본적으로 임계값의 5% 미만입니다. 이 백분율은 target_max_misplaced_ratio 설정을 사용하여 조정할 수 있습니다. 예를 들어 임계값을 7%로 늘리려면 다음을 수행합니다.

예제

[ceph: root@host01 /]# ceph config-key set mgr target_max_misplaced_ratio .07

자동 밸런싱의 경우:

- 자동 밸런서 실행 사이에 유휴 상태로 전환될 시간(초)을 설정합니다.

예제

[ceph: root@host01 /]# ceph config set mgr mgr/balancer/sleep_interval 60

- HHMM 형식으로 자동 밸런싱을 시작하도록 시간을 설정합니다.

예제

[ceph: root@host01 /]# ceph config set mgr mgr/balancer/begin_time 0000

- HHMM 형식의 자동 밸런싱을 완료하도록 시간을 설정합니다.

예제

[ceph: root@host01 /]# ceph config set mgr mgr/balancer/end_time 2359

-

이번 주 또는 이후 날짜로 자동 밸런싱을 제한합니다. crontab과 동일한 규칙을 사용하며

0은 일요일,1은 월요일 등입니다.

예제

[ceph: root@host01 /]# ceph config set mgr mgr/balancer/begin_weekday 0

-

이 요일 또는 이전 날짜로 자동 밸런싱을 제한합니다. 이 명령은 crontab과 동일한 규칙을 사용하며

0은 일요일,1은 월요일 등입니다.

예제

[ceph: root@host01 /]# ceph config set mgr mgr/balancer/end_weekday 6

-

자동 분산이 제한된 풀 ID를 정의합니다. 기본값은 빈 문자열이므로 모든 풀이 균형을 유지합니다.

ceph osd pool ls detail명령을 사용하여 숫자 풀 ID를 가져올 수 있습니다.

예제

[ceph: root@host01 /]# ceph config set mgr mgr/balancer/pool_ids 1,2,3

검증된 최적화

밸런서 작업은 다음과 같은 몇 가지 단계로 나뉩니다.

-

계획을만듭니다. -

현재 PG 배포를 위해 또는

계획을실행한 후 발생할 PG 배포를 위해 데이터 배포의 품질을 평가합니다. 계획을실행합니다.현재 배포를 평가하고 점수화하려면 다음을 수행합니다.

예제

[ceph: root@host01 /]# ceph balancer eval

단일 풀의 배포를 평가하려면 다음을 수행합니다.

구문

ceph balancer eval POOL_NAME예제

[ceph: root@host01 /]# ceph balancer eval rbd

평가에 대한 자세한 내용을 보려면 다음을 수행합니다.

예제

[ceph: root@host01 /]# ceph balancer eval-verbose ...

현재 구성된 모드를 사용하여 계획을 생성하려면 다음을 수행합니다.

구문

ceph balancer optimize PLAN_NAMEPLAN_NAME 을 사용자 지정 계획 이름으로 바꿉니다.

예제

[ceph: root@host01 /]# ceph balancer optimize rbd_123

계획의 내용을 보려면 다음을 수행합니다.

구문

ceph balancer show PLAN_NAME예제

[ceph: root@host01 /]# ceph balancer show rbd_123

이전 계획을 삭제하려면 다음을 수행합니다.

구문

ceph balancer rm PLAN_NAME예제

[ceph: root@host01 /]# ceph balancer rm rbd_123

현재 기록된 계획을 보려면 status 명령을 사용합니다.

[ceph: root@host01 /]# ceph balancer status

계획을 실행한 후 생성되는 배포의 품질을 계산하려면 다음을 수행합니다.

구문

ceph balancer eval PLAN_NAME예제

[ceph: root@host01 /]# ceph balancer eval rbd_123

계획을 실행하려면 다음을 수행합니다.

구문

ceph balancer execute PLAN_NAME예제

[ceph: root@host01 /]# ceph balancer execute rbd_123

참고배포를 개선할 것으로 예상되는 경우에만 계획을 실행합니다. 계획이 실행되면 계획이 삭제됩니다.

5.4.2. 읽기 밸런서를 사용하여 Red Hat Ceph 클러스터 밸런싱 [기술 프리뷰]

Read Balancer는 Red Hat Ceph Storage 7.0에만 기술 프리뷰 기능입니다. 기술 프리뷰 기능은 Red Hat 프로덕션 서비스 수준 계약(SLA)에서 지원되지 않으며 기능적으로 완전하지 않을 수 있으며 Red Hat은 해당 기능을 프로덕션용으로 사용하지 않는 것이 좋습니다. 이러한 기능을 사용하면 향후 제품 기능을 조기에 이용할 수 있어 개발 과정에서 고객이 기능을 테스트하고 피드백을 제공할 수 있습니다. 자세한 내용은 Red Hat 기술 프리뷰 기능에 대한 지원 범위를 참조하십시오.

균형이 맞지 않는 기본 OSD가 있는 경우 osdmaptool 에 빌드된 오프라인 Cryostat로 업데이트할 수 있습니다.

최상의 결과를 보장하기 위해 읽기 밸런서를 실행하기 전에 용량 밸런서를 실행하는 것이 좋습니다.

읽기 밸런서를 사용하여 클러스터의 균형을 조정하려면 절차의 단계를 따르십시오.

사전 요구 사항

- 실행 중이고 용량 균형을 이루는 Red Hat Ceph Storage 클러스터입니다.

최상의 결과를 보장하기 위해 읽기 밸런서를 실행하기 전에 용량 밸런서를 실행하여 각 OSD의 용량을 균형 있게 조정하는 것이 좋습니다. 다음 단계를 실행하여 용량의 균형을 조정합니다.

osdmap의 최신 사본을 가져옵니다.

[ceph: root@host01 /]# ceph osd getmap -o map

upmap 밸런서를 실행합니다.

[ceph: root@host01 /]# ospmaptool map –upmap out.txt

file out.txt에는 제안된 솔루션이 포함되어 있습니다.

이 절차의 명령은 클러스터에 변경 사항을 적용하기 위해 실행되는 일반 Ceph CLI 명령입니다.

out.txt 파일에 권장 사항이 있는 경우 다음 명령을 실행합니다.

[ceph: root@host01 /]# source out.txt

자세한 내용은 Balancing IBM Ceph cluster using capacity balancer에서 참조하십시오.

프로세스

각 풀에 사용할 수 있는

read_balance_score를 확인합니다.[ceph: root@host01 /]# ceph osd pool ls detail

read_balance_score가 1보다 큰 경우 풀에서 기본 OSD의 균형이 해제되었습니다.동종 클러스터의 경우 최적의 점수는 [Ceil{( PGs/Number of OSDs)}/( PGs/Number of OSDs)]/[ ( PGs/Number of OSDs)/(CPU 수의 PGs/Number)]입니다. 예를 들어 32개의 PG와 10개의 OSD가 있는 풀이 있는 경우 ( PGs/Number of OSDs) = 32/10 = 3.2입니다. 따라서 모든 장치가 동일한 경우 최적 점수는 4/3.2 = 1.25인 최적 점수가 3.2의 경우 ( PG/Number of OSDs)로 나뉩니다. 64 PG가 있는 동일한 시스템에 다른 풀이 있는 경우 최적의 점수는 7/6.4 =1.09375입니다.

출력 예:

$ ceph osd pool ls detail pool 1 '.mgr' replicated size 3 min_size 1 crush_rule 0 object_hash rjenkins pg_num 1 pgp_num 1 autoscale_mode on last_change 17 flags hashpspool stripe_width 0 pg_num_max 32 pg_num_min 1 application mgr read_balance_score 3.00 pool 2 'cephfs.a.meta' replicated size 3 min_size 1 crush_rule 0 object_hash rjenkins pg_num 16 pgp_num 16 autoscale_mode on last_change 55 lfor 0/0/25 flags hashpspool stripe_width 0 pg_autoscale_bias 4 pg_num_min 16 recovery_priority 5 application cephfs read_balance_score 1.50 pool 3 'cephfs.a.data' replicated size 3 min_size 1 crush_rule 0 object_hash rjenkins pg_num 128 pgp_num 128 autoscale_mode on last_change 27 lfor 0/0/25 flags hashpspool,bulk stripe_width 0 application cephfs read_balance_score 1.31

osdmap의 최신 사본을 가져옵니다.[ceph: root@host01 /]# ceph osd getmap -o om

출력 예:

got osdmap epoch 56

Cryostat를 실행합니다.

file

out.txt에는 제안된 솔루션이 포함되어 있습니다.[ceph: root@host01 /]# osdmaptool om --read out.txt --read-pool _POOL_NAME_ [--vstart]

출력 예:

$ osdmaptool om --read out.txt --read-pool cephfs.a.meta ./bin/osdmaptool: osdmap file 'om' writing upmap command output to: out.txt ---------- BEFORE ------------ osd.0 | primary affinity: 1 | number of prims: 4 osd.1 | primary affinity: 1 | number of prims: 8 osd.2 | primary affinity: 1 | number of prims: 4 read_balance_score of 'cephfs.a.meta': 1.5 ---------- AFTER ------------ osd.0 | primary affinity: 1 | number of prims: 5 osd.1 | primary affinity: 1 | number of prims: 6 osd.2 | primary affinity: 1 | number of prims: 5 read_balance_score of 'cephfs.a.meta': 1.13 num changes: 2

file

out.txt에는 제안된 솔루션이 포함되어 있습니다.이 절차의 명령은 클러스터에 변경 사항을 적용하기 위해 실행되는 일반 Ceph CLI 명령입니다. vstart 클러스터에서 작업하는 경우 CLI 명령이

./bin/ 접두사로 포맷되도록--vstart매개변수를 전달할 수 있습니다.[ceph: root@host01 /]# source out.txt

출력 예:

$ cat out.txt ceph osd pg-upmap-primary 2.3 0 ceph osd pg-upmap-primary 2.4 2 $ source out.txt change primary for pg 2.3 to osd.0 change primary for pg 2.4 to osd.2

참고ceph osd pg-upmap-primary명령을 처음 실행하는 경우 다음과 같이 경고가 표시될 수 있습니다.Error EPERM: min_compat_client luminous < reef, which is required for pg-upmap-primary. Try 'ceph osd set-require-min-compat-client reef' before using the new interface

이 경우 권장 명령

ceph osd set-require-min-compat-client reef를 실행하고 클러스터의 min-compact-client를 조정합니다.

배치 그룹(PG) 수가 변경되거나 클러스터에서 OSD가 추가되거나 제거된 경우 이러한 작업이 풀에 읽기 밸런서 효과에 상당한 영향을 미칠 수 있으므로 점수를 다시 확인하고 밸런서를 다시 실행하는 것이 좋습니다.

5.5. Ceph Manager 경고 모듈 사용

Ceph Manager 경고 모듈을 사용하여 이메일로 Red Hat Ceph Storage 클러스터 상태에 대한 간단한 경고 메시지를 보낼 수 있습니다.

이 모듈은 강력한 모니터링 솔루션이 아닙니다. Ceph 클러스터 자체의 일부로 실행된다는 사실은 ceph-mgr 데몬 실패로 인해 경고가 전송되지 않도록 근본적으로 제한됩니다. 그러나 이 모듈은 기존 모니터링 인프라가 없는 환경에 존재하는 독립 실행형 클러스터에 유용할 수 있습니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- Ceph Monitor 노드에 대한 루트 수준 액세스.

프로세스

Cephadm 쉘에 로그인합니다.

예제

[root@host01 ~]# cephadm shell

alerts 모듈을 활성화합니다.

예제

[ceph: root@host01 /]# ceph mgr module enable alerts

alerts 모듈이 활성화되었는지 확인합니다.

예제

[ceph: root@host01 /]# ceph mgr module ls | more { "always_on_modules": [ "balancer", "crash", "devicehealth", "orchestrator", "pg_autoscaler", "progress", "rbd_support", "status", "telemetry", "volumes" ], "enabled_modules": [ "alerts", "cephadm", "dashboard", "iostat", "nfs", "prometheus", "restful" ]SMTP(Simple Mail Transfer Protocol)를 구성합니다.

구문

ceph config set mgr mgr/alerts/smtp_host SMTP_SERVER ceph config set mgr mgr/alerts/smtp_destination RECEIVER_EMAIL_ADDRESS ceph config set mgr mgr/alerts/smtp_sender SENDER_EMAIL_ADDRESS

예제

[ceph: root@host01 /]# ceph config set mgr mgr/alerts/smtp_host smtp.example.com [ceph: root@host01 /]# ceph config set mgr mgr/alerts/smtp_destination example@example.com [ceph: root@host01 /]# ceph config set mgr mgr/alerts/smtp_sender example2@example.com

선택 사항: 기본적으로 alerts 모듈은 SSL 및 포트 465를 사용합니다.

구문

ceph config set mgr mgr/alerts/smtp_port PORT_NUMBER예제

[ceph: root@host01 /]# ceph config set mgr mgr/alerts/smtp_port 587

경고를 구성하는 동안

smtp_ssl매개변수를 설정하지 마십시오.SMTP 서버에 인증합니다.

구문

ceph config set mgr mgr/alerts/smtp_user USERNAME ceph config set mgr mgr/alerts/smtp_password PASSWORD

예제

[ceph: root@host01 /]# ceph config set mgr mgr/alerts/smtp_user admin1234 [ceph: root@host01 /]# ceph config set mgr mgr/alerts/smtp_password admin1234

선택 사항: 기본적으로 이름에 따라 SMTP는

Ceph입니다.이를 변경하려면smtp_from_name매개변수를 설정합니다.구문

ceph config set mgr mgr/alerts/smtp_from_name CLUSTER_NAME예제

[ceph: root@host01 /]# ceph config set mgr mgr/alerts/smtp_from_name 'Ceph Cluster Test'

선택 사항: 기본적으로 alerts 모듈은 1분마다 스토리지 클러스터의 상태를 확인하고 클러스터 상태가 변경될 때 메시지를 보냅니다. 빈도를 변경하려면

interval매개변수를 설정합니다.구문

ceph config set mgr mgr/alerts/interval INTERVAL예제

[ceph: root@host01 /]# ceph config set mgr mgr/alerts/interval "5m"

이 예에서 간격은 5분으로 설정됩니다.

선택 사항: 즉시 경고를 보냅니다.

예제

[ceph: root@host01 /]# ceph alerts send

추가 리소스

- Ceph 상태 메시지에 대한 자세한 내용은 Red Hat Ceph Storage 문제 해결 가이드에서 Ceph 클러스터 의 상태 메시지 섹션을 참조하십시오.

5.6. Ceph manager 크래시 모듈 사용

Ceph manager 크래시 모듈을 사용하면 데몬 크래시 덤프에 대한 정보를 수집하여 추가 분석을 위해 Red Hat Ceph Storage 클러스터에 저장할 수 있습니다.

기본적으로 데몬 크래시 덤프는 /var/lib/ceph/crash 에 덤프됩니다. 옵션 크래시 dir 을 사용하여 구성할 수 있습니다. 크래시 디렉터리는 시간, 날짜 및 무작위로 생성된 UUID에 따라 이름이 지정되며 동일한 crash_id 가 있는 메타데이터 파일 메타 및 최근 로그 파일을 포함합니다.

ceph-crash.service 를 사용하여 이러한 충돌을 자동으로 제출하고 Ceph 모니터에 유지할 수 있습니다. ceph-crash.service 는 crashdump 디렉터리를 감시하고 ceph 크래시 게시물 로 업로드합니다.

RECENT_CRASH heath 메시지는 Ceph 클러스터에서 가장 일반적인 상태 메시지 중 하나입니다. 이 상태 메시지는 최근에 하나 이상의 Ceph 데몬이 충돌했으며 충돌은 아직 관리자가 보관하거나 승인하지 않았음을 의미합니다. 이는 소프트웨어 버그, 디스크 오류와 같은 하드웨어 문제 또는 다른 문제를 나타낼 수 있습니다. 옵션 mgr/crash/warn_recent_interval 은 기본적으로 2주인 최근의 의미의 기간을 제어합니다. 다음 명령을 실행하여 경고를 비활성화할 수 있습니다.

예제

[ceph: root@host01 /]# ceph config set mgr/crash/warn_recent_interval 0

mgr/crash/retain_interval 옵션은 충돌 보고서를 자동으로 제거하기 전에 유지하려는 기간을 제어합니다. 이 옵션의 기본값은 1년입니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

프로세스

crash 모듈이 활성화되었는지 확인합니다.

예제

[ceph: root@host01 /]# ceph mgr module ls | more { "always_on_modules": [ "balancer", "crash", "devicehealth", "orchestrator_cli", "progress", "rbd_support", "status", "volumes" ], "enabled_modules": [ "dashboard", "pg_autoscaler", "prometheus" ]크래시 덤프 저장: 메타데이터 파일은 크래시 디렉터리에

메타로 저장된 JSON Blob입니다. stdin에서 읽는 ceph command-i -옵션을 호출할 수 있습니다.예제

[ceph: root@host01 /]# ceph crash post -i meta

모든 신규 및 아카이브된 크래시 정보의 타임스탬프 또는 UUID 충돌 ID를 나열합니다.

예제

[ceph: root@host01 /]# ceph crash ls

모든 새로운 충돌 정보의 타임스탬프 또는 UUID 충돌 ID를 나열합니다.

예제

[ceph: root@host01 /]# ceph crash ls-new

모든 새로운 충돌 정보의 타임스탬프 또는 UUID 충돌 ID를 나열합니다.

예제

[ceph: root@host01 /]# ceph crash ls-new

저장된 충돌 정보의 요약을 기간별로 그룹화합니다.

예제

[ceph: root@host01 /]# ceph crash stat 8 crashes recorded 8 older than 1 days old: 2022-05-20T08:30:14.533316Z_4ea88673-8db6-4959-a8c6-0eea22d305c2 2022-05-20T08:30:14.590789Z_30a8bb92-2147-4e0f-a58b-a12c2c73d4f5 2022-05-20T08:34:42.278648Z_6a91a778-bce6-4ef3-a3fb-84c4276c8297 2022-05-20T08:34:42.801268Z_e5f25c74-c381-46b1-bee3-63d891f9fc2d 2022-05-20T08:34:42.803141Z_96adfc59-be3a-4a38-9981-e71ad3d55e47 2022-05-20T08:34:42.830416Z_e45ed474-550c-44b3-b9bb-283e3f4cc1fe 2022-05-24T19:58:42.549073Z_b2382865-ea89-4be2-b46f-9a59af7b7a2d 2022-05-24T19:58:44.315282Z_1847afbc-f8a9-45da-94e8-5aef0738954e

저장된 충돌의 세부 정보를 확인합니다.

구문

ceph crash info CRASH_ID예제

[ceph: root@host01 /]# ceph crash info 2022-05-24T19:58:42.549073Z_b2382865-ea89-4be2-b46f-9a59af7b7a2d { "assert_condition": "session_map.sessions.empty()", "assert_file": "/builddir/build/BUILD/ceph-16.1.0-486-g324d7073/src/mon/Monitor.cc", "assert_func": "virtual Monitor::~Monitor()", "assert_line": 287, "assert_msg": "/builddir/build/BUILD/ceph-16.1.0-486-g324d7073/src/mon/Monitor.cc: In function 'virtual Monitor::~Monitor()' thread 7f67a1aeb700 time 2022-05-24T19:58:42.545485+0000\n/builddir/build/BUILD/ceph-16.1.0-486-g324d7073/src/mon/Monitor.cc: 287: FAILED ceph_assert(session_map.sessions.empty())\n", "assert_thread_name": "ceph-mon", "backtrace": [ "/lib64/libpthread.so.0(+0x12b30) [0x7f679678bb30]", "gsignal()", "abort()", "(ceph::__ceph_assert_fail(char const*, char const*, int, char const*)+0x1a9) [0x7f6798c8d37b]", "/usr/lib64/ceph/libceph-common.so.2(+0x276544) [0x7f6798c8d544]", "(Monitor::~Monitor()+0xe30) [0x561152ed3c80]", "(Monitor::~Monitor()+0xd) [0x561152ed3cdd]", "main()", "__libc_start_main()", "_start()" ], "ceph_version": "16.2.8-65.el8cp", "crash_id": "2022-07-06T19:58:42.549073Z_b2382865-ea89-4be2-b46f-9a59af7b7a2d", "entity_name": "mon.ceph-adm4", "os_id": "rhel", "os_name": "Red Hat Enterprise Linux", "os_version": "8.5 (Ootpa)", "os_version_id": "8.5", "process_name": "ceph-mon", "stack_sig": "957c21d558d0cba4cee9e8aaf9227b3b1b09738b8a4d2c9f4dc26d9233b0d511", "timestamp": "2022-07-06T19:58:42.549073Z", "utsname_hostname": "host02", "utsname_machine": "x86_64", "utsname_release": "4.18.0-240.15.1.el8_3.x86_64", "utsname_sysname": "Linux", "utsname_version": "#1 SMP Wed Jul 06 03:12:15 EDT 2022" }KEEP 일보다 저장된 충돌 제거: 여기에서 KEEP 는 정수여야 합니다.

구문

ceph crash prune KEEP예제

[ceph: root@host01 /]# ceph crash prune 60

더 이상

RECENT_CRASH상태 점검으로 간주되지 않고크래시 ls-new 출력에 표시되지 않도록 크래시보고서를 보관합니다.충돌 ls에 나타납니다.구문

ceph crash archive CRASH_ID예제

[ceph: root@host01 /]# ceph crash archive 2022-05-24T19:58:42.549073Z_b2382865-ea89-4be2-b46f-9a59af7b7a2d

모든 충돌 보고서를 보관합니다.

예제

[ceph: root@host01 /]# ceph crash archive-all

크래시 덤프 제거:

구문

ceph crash rm CRASH_ID예제

[ceph: root@host01 /]# ceph crash rm 2022-05-24T19:58:42.549073Z_b2382865-ea89-4be2-b46f-9a59af7b7a2d

추가 리소스

- Ceph 상태 메시지에 대한 자세한 내용은 Red Hat Ceph Storage 문제 해결 가이드에서 Ceph 클러스터 의 상태 메시지 섹션을 참조하십시오.

5.7. Telemetry 모듈

Telemetry 모듈은 스토리지 클러스터에 대한 데이터를 전송하여 Ceph 사용 방법과 작업 중에 발생하는 문제를 이해하는 데 도움이 됩니다. 데이터는 공용 대시보드에 시각화되어 보고되는 클러스터 수, 총 용량 및 OSD 수, 버전 배포 추세에 대한 요약 통계를 확인합니다.

채널

원격 분석 보고서는 각각 다른 유형의 정보를 가진 다양한 채널로 나뉩니다. Telemetry가 활성화되면 개별 채널을 켜거나 끌 수 있습니다.

다음은 4개의 다른 채널입니다.

Basic- 기본값은on입니다. 이 채널은 다음 정보를 포함하는 클러스터에 대한 기본 정보를 제공합니다.- 클러스터의 용량입니다.

- 모니터, 관리자, OSD, MDSs, 오브젝트 게이트웨이 또는 기타 데몬의 수입니다.

- 현재 사용 중인 소프트웨어 버전입니다.

- RADOS 풀 및 Ceph 파일 시스템의 수 및 유형입니다.

- 기본값(값이 아님)에서 변경된 구성 옵션의 이름입니다.

crash- 기본값은on입니다. 이 채널은 다음 정보를 포함하는 데몬 충돌에 대한 정보를 제공합니다.- 데몬 유형입니다.

- 데몬의 버전입니다.

- 운영 체제, OS 배포 및 커널 버전입니다.

- Ceph 코드에서 크래시가 발생한 위치를 식별하는 스택 추적입니다.

-

device- 기본값은입니다. 이 채널은 익명화된 SMART 메트릭을 포함하는 장치 메트릭에 대한 정보를 제공합니다. -

idENT - 기본값은OFF입니다. 이 채널은 클러스터 설명과 같은 클러스터에 대한 사용자 제공 식별 정보 및 연락처 이메일 주소를 제공합니다. perf- 기본값은OFF입니다. 이 채널은 클러스터의 다양한 성능 지표를 제공하며, 이는 다음에 사용할 수 있습니다.- 전체 클러스터 상태를 표시합니다.

- 워크로드 패턴을 식별합니다.

- 대기 시간, 제한, 메모리 관리 및 기타 유사한 문제에 대한 문제를 해결합니다.

- 데몬을 통해 클러스터 성능을 모니터링합니다.

보고된 데이터에는 풀 이름, 오브젝트 이름, 오브젝트 콘텐츠, 호스트 이름 또는 장치 일련 번호와 같은 중요한 데이터가 포함되어 있지 않습니다.

클러스터 배포 방법, Ceph 버전, 호스트 배포 및 Ceph 사용 방식을 보다 잘 이해하는 데 도움이 되는 기타 매개 변수에 대한 카운터 및 통계가 포함되어 있습니다.

데이터는 안전하며 https://telemetry.ceph.com 로 전송됩니다.

Telemetry 활성화

채널을 활성화하기 전에 Telemetry가 켜져 있는지 확인합니다.

Telemetry를 활성화합니다.

ceph telemetry on

채널 활성화 및 비활성화

개별 채널을 활성화 또는 비활성화합니다.

ceph telemetry enable channel basic ceph telemetry enable channel crash ceph telemetry enable channel device ceph telemetry enable channel ident ceph telemetry enable channel perf ceph telemetry disable channel basic ceph telemetry disable channel crash ceph telemetry disable channel device ceph telemetry disable channel ident ceph telemetry disable channel perf

여러 채널을 활성화하거나 비활성화합니다.

ceph telemetry enable channel basic crash device ident perf ceph telemetry disable channel basic crash device ident perf

모든 채널을 함께 활성화 또는 비활성화합니다.

ceph telemetry enable channel all ceph telemetry disable channel all

샘플 보고서

언제든지 보고된 데이터를 검토하려면 샘플 보고서를 생성합니다.

ceph telemetry show

Telemetry가

꺼져있는 경우 샘플 보고서를 미리 봅니다.ceph telemetry preview

수백 개의 OSD 이상이 있는 스토리지 클러스터에 대한 샘플 보고서를 생성하는 데 시간이 오래 걸립니다.

개인 정보를 보호하기 위해 장치 보고서가 별도로 생성되고 호스트 이름 및 장치 일련 번호와 같은 데이터는 익명화됩니다. 장치 Telemetry는 다른 끝점으로 전송되며 장치 데이터를 특정 클러스터와 연결하지 않습니다. 장치 보고서를 보려면 다음 명령을 실행합니다.

ceph telemetry show-device

Telemetry가

꺼져있는 경우 샘플 장치 보고서를 미리 봅니다.ceph telemetry preview-device

: :

에Telemetry가 있는 두 보고서의 단일 출력을 가져옵니다.ceph telemetry show-all

Telemetry

off가 포함된 두 보고서의 단일 출력을 가져옵니다.ceph telemetry preview-all

채널별 샘플 보고서를 생성합니다.

구문

ceph telemetry show CHANNEL_NAME채널별 샘플 보고서의 프리뷰를 생성합니다.

구문

ceph telemetry preview CHANNEL_NAME

컬렉션

컬렉션은 채널 내에서 수집되는 데이터의 다양한 측면입니다.

컬렉션을 나열합니다.

ceph telemetry collection ls

등록된 컬렉션과 사용 가능한 새 컬렉션 간의 차이점을 참조하십시오.

ceph telemetry diff

최신 컬렉션에 등록합니다.

구문

ceph telemetry on ceph telemetry enable channel CHANNEL_NAME

간격

모듈은 기본적으로 24시간마다 새 보고서를 컴파일하고 보냅니다.

간격을 조정합니다.

구문

ceph config set mgr mgr/telemetry/interval INTERVAL예제

[ceph: root@host01 /]# ceph config set mgr mgr/telemetry/interval 72

이 예제에서는 3일(72시간)마다 보고서가 생성됩니다.

상태

현재 구성을 확인합니다.

ceph telemetry status

Telemetry 수동 전송

임시로 Telemetry 데이터를 보냅니다.

ceph telemetry send

Telemetry가 비활성화된 경우

ceph telemetry send명령에--license sharing-1-0을 추가합니다.

프록시를 통해 Telemetry 전송

클러스터가 구성된 Telemetry 끝점에 직접 연결할 수 없는 경우 HTTP/HTTPs 프록시 서버를 구성할 수 있습니다.

구문

ceph config set mgr mgr/telemetry/proxy PROXY_URL예제

[ceph: root@host01 /]# ceph config set mgr mgr/telemetry/proxy https://10.0.0.1:8080

user pass를 명령에 포함할 수 있습니다.

예제

[ceph: root@host01 /]# ceph config set mgr mgr/telemetry/proxy https://10.0.0.1:8080

연락처 및 설명

선택 사항: 보고서에 연락처 및 설명을 추가합니다.

구문

ceph config set mgr mgr/telemetry/contact '_CONTACT_NAME_' ceph config set mgr mgr/telemetry/description '_DESCRIPTION_' ceph config set mgr mgr/telemetry/channel_ident true

예제

[ceph: root@host01 /]# ceph config set mgr mgr/telemetry/contact 'John Doe <john.doe@example.com>' [ceph: root@host01 /]# ceph config set mgr mgr/telemetry/description 'My first Ceph cluster' [ceph: root@host01 /]# ceph config set mgr mgr/telemetry/channel_ident true

ident플래그가 활성화되면 해당 세부 정보가 리더보드에 표시되지 않습니다.

Leaderboard

공용 대시보드의 리더 보드에 참여하십시오.

예제

[ceph: root@host01 /]# ceph config set mgr mgr/telemetry/leaderboard true

leaderboard에는 스토리지 클러스터에 대한 기본 정보가 표시됩니다. 이 보드에는 총 스토리지 용량과 OSD 수가 포함됩니다.

Telemetry 비활성화

언제든지 Telemetry를 비활성화합니다.

예제

ceph telemetry off

6장. Ceph Orchestrator를 사용하여 OSD 관리

스토리지 관리자는 Ceph Orchestrators를 사용하여 Red Hat Ceph Storage 클러스터의 OSD를 관리할 수 있습니다.

6.1. Ceph OSD

Red Hat Ceph Storage 클러스터가 가동되어 실행되면 런타임 시 스토리지 클러스터에 OSD를 추가할 수 있습니다.

Ceph OSD는 일반적으로 하나의 스토리지 드라이브와 노드 내의 관련 저널을 위한 하나의 ceph-osd 데몬으로 구성됩니다. 노드에 스토리지 드라이브가 여러 개 있는 경우 각 드라이브에 대해 하나의 ceph-osd 데몬을 매핑합니다.

Red Hat은 클러스터의 용량을 정기적으로 확인하여 스토리지 용량의 상단에 도달하고 있는지 확인하는 것이 좋습니다. 스토리지 클러스터가 거의 전체 비율에 도달하면 하나 이상의 OSD를 추가하여 스토리지 클러스터의 용량을 확장합니다.

Red Hat Ceph Storage 클러스터의 크기를 줄이거나 하드웨어를 교체하려는 경우 런타임 시 OSD도 제거할 수 있습니다. 노드에 스토리지 드라이브가 여러 개 있는 경우 해당 드라이브의 ceph-osd 데몬 중 하나를 제거해야 할 수도 있습니다. 일반적으로 스토리지 클러스터의 용량을 확인하여 용량의 상단에 도달하고 있는지 확인하는 것이 좋습니다. 스토리지 클러스터가 거의 전체 비율에 있지 않은 OSD를 제거해야 합니다.

OSD를 추가하기 전에 스토리지 클러스터가 전체 비율에 도달하도록 허용하지 마십시오. 스토리지 클러스터가 거의 전체 비율에 도달한 후 발생하는 OSD 오류로 인해 스토리지 클러스터가 전체 비율을 초과할 수 있습니다. Ceph 블록은 스토리지 용량 문제를 해결할 때까지 데이터를 보호하기 위해 쓰기 액세스 권한을 차단합니다. 먼저 전체 비율에 미치는 영향을 고려하지 않고 OSD를 제거하지 마십시오.

6.2. Ceph OSD 노드 구성

Ceph OSD와 지원 하드웨어를 OSD를 사용할 풀의 스토리지 전략과 유사하게 구성합니다. Ceph는 일관된 성능 프로파일을 위해 풀 전체에서 균일한 하드웨어를 선호합니다. 최상의 성능을 위해 동일한 유형 또는 크기의 드라이브가 있는 CRUSH 계층 구조를 고려하십시오.

다른 크기의 드라이브를 추가하는 경우 그에 따라 가중치를 조정합니다. CRUSH 맵에 OSD를 추가할 때 새 OSD의 가중치를 고려하십시오. 하드 드라이브 용량은 연간 약 40% 증가하므로 최신 OSD 노드에는 스토리지 클러스터의 이전 노드보다 더 큰 하드 드라이브가 있을 수 있습니다. 즉, 가중치가 클 수 있습니다.

새 설치를 수행하기 전에 설치 가이드의 Red Hat Ceph Storage 설치 요구 사항 장을 참조하십시오.

6.3. OSD 메모리 자동 튜닝

OSD 데몬은 osd_memory_target 구성 옵션을 기반으로 메모리 사용을 조정합니다. osd_memory_target 옵션은 시스템에서 사용 가능한 RAM에 따라 OSD 메모리를 설정합니다.

Red Hat Ceph Storage가 다른 서비스와 메모리를 공유하지 않는 전용 노드에 배포된 경우 cephadm 은 총 RAM 양 및 배포된 OSD 수에 따라 자동으로 OSD 소비를 조정합니다.

기본적으로 osd_memory_target_autotune 매개변수는 Red Hat Ceph Storage 클러스터에서 true 로 설정됩니다.

구문

ceph config set osd osd_memory_target_autotune true

cephadm 은 mgr/cephadm/autotune_memory_target_ratio 로 시작합니다. 기본값은 시스템의 총 RAM으로, 비 자동 조정되지 않은 데몬에서 사용하는 메모리를 제거하고 osd_memory_target_autotune 이 false인 OSD로 나눕니다.

osd_memory_target 매개변수는 다음과 같이 계산됩니다.

구문

osd_memory_target = TOTAL_RAM_OF_THE_OSD * (1048576) * (autotune_memory_target_ratio) / NUMBER_OF_OSDS_IN_THE_OSD_NODE - (SPACE_ALLOCATED_FOR_OTHER_DAEMONS)

SPACE_ALLOCATED_FOR_OTHER_DAEMONS 는 선택적으로 다음 데몬 공간 할당을 포함할 수 있습니다.

- Alertmanager: 1GB

- Grafana: 1GB

- Ceph Manager: 4GB

- Ceph 모니터: 2GB

- node-exporter: 1GB

- Prometheus: 1GB

예를 들어 노드에 24개의 OSD가 있고 251GB RAM 공간이 있는 경우 osd_memory_target 은 7860684936 입니다.

최종 대상은 옵션을 사용하여 구성 데이터베이스에 반영됩니다. MEM LIMIT 열의 ceph orch ps 출력에서 각 데몬에서 사용하는 제한 및 현재 메모리를 볼 수 있습니다.

osd_memory_target_autotune true 의 기본 설정은 컴퓨팅 및 Ceph 스토리지 서비스가 배치되는 하이퍼 컨버지드 인프라에 적합하지 않습니다. 하이퍼컨버지드 인프라에서 autotune_memory_target_ratio 를 0.2 로 설정하여 Ceph의 메모리 사용량을 줄일 수 있습니다.

예제

[ceph: root@host01 /]# ceph config set mgr mgr/cephadm/autotune_memory_target_ratio 0.2

스토리지 클러스터에서 OSD의 특정 메모리 대상을 수동으로 설정할 수 있습니다.

예제

[ceph: root@host01 /]# ceph config set osd.123 osd_memory_target 7860684936

스토리지 클러스터에서 OSD 호스트의 특정 메모리 대상을 수동으로 설정할 수 있습니다.

구문

ceph config set osd/host:HOSTNAME osd_memory_target TARGET_BYTES

예제

[ceph: root@host01 /]# ceph config set osd/host:host01 osd_memory_target 1000000000

osd_memory_target_autotune 을 활성화하면 기존 수동 OSD 메모리 대상 설정을 덮어씁니다. osd_memory_target_autotune 옵션 또는 기타 유사한 옵션이 활성화된 경우에도 데몬 메모리가 튜닝되지 않도록 하려면 호스트에서 _no_autotune_memory 레이블을 설정합니다.

구문

ceph orch host label add HOSTNAME _no_autotune_memory

autotune 옵션을 비활성화하고 특정 메모리 대상을 설정하여 OSD를 메모리 자동 튜닝에서 제외할 수 있습니다.

예제

[ceph: root@host01 /]# ceph config set osd.123 osd_memory_target_autotune false [ceph: root@host01 /]# ceph config set osd.123 osd_memory_target 16G

6.4. Ceph OSD 배포를 위한 장치 나열

Ceph Orchestrator를 사용하여 OSD를 배포하기 전에 사용 가능한 장치 목록을 확인할 수 있습니다. 명령은 Cephadm에서 검색할 수 있는 장치 목록을 인쇄하는 데 사용됩니다. 다음 조건이 모두 충족되면 스토리지 장치를 사용할 수 있는 것으로 간주됩니다.

- 장치에 파티션이 없어야 합니다.

- 장치에 LVM 상태가 없어야 합니다.

- 장치를 마운트해서는 안 됩니다.

- 장치에 파일 시스템을 포함할 수 없습니다.

- 장치에 Ceph BlueStore OSD가 포함되어 있지 않아야 합니다.

- 장치는 5GB보다 커야 합니다.

Ceph는 사용할 수 없는 장치에 OSD를 프로비저닝하지 않습니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 호스트가 클러스터에 추가됩니다.

- 모든 관리자 및 모니터 데몬이 배포됩니다.

프로세스

Cephadm 쉘에 로그인합니다.

예제

[root@host01 ~]# cephadm shell

OSD를 배포할 사용 가능한 장치를 나열합니다.

구문

ceph orch device ls [--hostname=HOSTNAME_1 HOSTNAME_2] [--wide] [--refresh]

예제

[ceph: root@host01 /]# ceph orch device ls --wide --refresh

--wide옵션을 사용하면 장치가 OSD로 사용할 수 없는 이유를 포함하여 장치와 관련된 모든 세부 정보를 제공합니다. 이 옵션은 NVMe 장치를 지원하지 않습니다.선택 사항:

ceph orch 장치 ls의 출력에서 Health,Ident 및 Fault 필드를 활성화하려면 다음 명령을 실행합니다.참고이러한 필드는

libstoragemgmt라이브러리에서 지원하며 현재 SCSI, SAS 및 SATA 장치를 지원합니다.Cephadm 쉘 외부의 root 사용자로

libstoragemgmt라이브러리와의 하드웨어 호환성을 확인하여 서비스에 대한 계획되지 않은 중단을 방지합니다.예제

[root@host01 ~]# cephadm shell lsmcli ldl

출력에 각 SCSI VPD 0x83 ID를 사용하여 Health Status 가 good로 표시됩니다.

참고이 정보를 얻지 못하면 필드를 활성화하면 장치의 비정상적인 동작이 발생할 수 있습니다.

Cephadm 쉘로 다시 로그인하고

libstoragemgmt지원을 활성화합니다.예제

[root@host01 ~]# cephadm shell [ceph: root@host01 /]# ceph config set mgr mgr/cephadm/device_enhanced_scan true

이 기능이 활성화되면

ceph orch device ls는 Health 필드의 출력을 good로 제공합니다.

검증

장치를 나열합니다.

예제

[ceph: root@host01 /]# ceph orch device ls

6.5. Ceph OSD 배포를 위한 zapping 장치

OSD를 배포하기 전에 사용 가능한 장치 목록을 확인해야 합니다. 장치에 사용 가능한 공간이 없는 경우 zapping하여 장치의 데이터를 지울 수 있습니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 호스트가 클러스터에 추가됩니다.

- 모든 관리자 및 모니터 데몬이 배포됩니다.

프로세스

Cephadm 쉘에 로그인합니다.

예제

[root@host01 ~]# cephadm shell

OSD를 배포할 사용 가능한 장치를 나열합니다.

구문

ceph orch device ls [--hostname=HOSTNAME_1 HOSTNAME_2] [--wide] [--refresh]

예제

[ceph: root@host01 /]# ceph orch device ls --wide --refresh

장치의 데이터를 지웁니다.

구문

ceph orch device zap HOSTNAME FILE_PATH --force

예제

[ceph: root@host01 /]# ceph orch device zap host02 /dev/sdb --force

검증

장치에서 공간을 사용할 수 있는지 확인합니다.

예제

[ceph: root@host01 /]# ceph orch device ls

Available 아래에 있는 필드가 Yes 임을 확인할 수 있습니다.

추가 리소스

- 자세한 내용은 Red Hat Ceph Storage Operations Guide의 Ceph OSD 배포 목록 섹션을 참조하십시오.

6.6. 사용 가능한 모든 장치에 Ceph OSD 배포

사용 가능한 모든 장치에 모든 OSDS를 배포할 수 있습니다. cephadm을 사용하면 Ceph Orchestrator가 사용 가능하고 사용되지 않는 스토리지 장치에 OSD를 검색하고 배포할 수 있습니다.

사용 가능한 모든 장치를 배포하려면 관리되지 않는 매개 변수 없이 명령을 실행한 다음, 향후 OSD를 생성하지 못하도록 매개 변수를 사용하여 명령을 다시 실행합니다.

일반적으로 --all-available-devices 가 포함된 OSD 배포는 소규모 클러스터에 사용됩니다. 대규모 클러스터의 경우 OSD 사양 파일을 사용합니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 호스트가 클러스터에 추가됩니다.

- 모든 관리자 및 모니터 데몬이 배포됩니다.

프로세스

Cephadm 쉘에 로그인합니다.

예제

[root@host01 ~]# cephadm shell

OSD를 배포할 사용 가능한 장치를 나열합니다.

구문

ceph orch device ls [--hostname=HOSTNAME_1 HOSTNAME_2] [--wide] [--refresh]

예제

[ceph: root@host01 /]# ceph orch device ls --wide --refresh

사용 가능한 모든 장치에 OSD를 배포합니다.

예제

[ceph: root@host01 /]# ceph orch apply osd --all-available-devices

ceph orch apply의 영향은 영속적입니다. 즉 Orchestrator가 장치를 자동으로 찾아 클러스터에 추가하고 새 OSD를 생성합니다. 이는 다음 조건에서 수행됩니다.- 새 디스크 또는 드라이브가 시스템에 추가됩니다.

- 기존 디스크 또는 드라이브가 zapped입니다.

OSD가 제거되고 장치가 zapped됩니다.

--unmanaged매개변수를 사용하여 사용 가능한 모든 장치에서 OSD 자동 생성을 비활성화할 수 있습니다.예제

[ceph: root@host01 /]# ceph orch apply osd --all-available-devices --unmanaged=true

--unmanaged매개변수를true로 설정하면 OSD 생성이 비활성화되고 새 OSD 서비스를 적용하는 경우 변경 사항도 발생하지 않습니다.참고ceph orch 데몬 add명령은 새 OSD를 생성하지만 OSD 서비스를 추가하지 않습니다.

검증

서비스를 나열합니다.

예제

[ceph: root@host01 /]# ceph orch ls

노드 및 장치의 세부 정보를 확인합니다.

예제

[ceph: root@host01 /]# ceph osd tree

추가 리소스

- Red Hat Ceph Storage Operations Guide의 Ceph OSD 배포 목록 섹션을 참조하십시오.

6.7. 특정 장치 및 호스트에 Ceph OSD 배포

Ceph Orchestrator를 사용하여 특정 장치 및 호스트에 모든 Ceph OSD를 배포할 수 있습니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 호스트가 클러스터에 추가됩니다.

- 모든 관리자 및 모니터 데몬이 배포됩니다.

프로세스

Cephadm 쉘에 로그인합니다.

예제

[root@host01 ~]# cephadm shell

OSD를 배포할 사용 가능한 장치를 나열합니다.

구문

ceph orch device ls [--hostname=HOSTNAME_1 HOSTNAME_2] [--wide] [--refresh]

예제

[ceph: root@host01 /]# ceph orch device ls --wide --refresh

특정 장치 및 호스트에 OSD를 배포합니다.

구문

ceph orch daemon add osd HOSTNAME:DEVICE_PATH

예제

[ceph: root@host01 /]# ceph orch daemon add osd host02:/dev/sdb

LVM 계층 없이 원시 물리적 장치에 ODS를 배포하려면

--method raw옵션을 사용합니다.구문

ceph orch daemon add osd --method raw HOSTNAME:DEVICE_PATH

예제

[ceph: root@host01 /]# ceph orch daemon add osd --method raw host02:/dev/sdb

참고DB 또는 WAL 장치가 별도의 경우 블록 대 DB 또는 WAL 장치의 비율은 1:1 이어야합니다.

검증

서비스를 나열합니다.

예제

[ceph: root@host01 /]# ceph orch ls osd

노드 및 장치의 세부 정보를 확인합니다.

예제

[ceph: root@host01 /]# ceph osd tree

호스트, 데몬 및 프로세스를 나열합니다.

구문

ceph orch ps --service_name=SERVICE_NAME예제

[ceph: root@host01 /]# ceph orch ps --service_name=osd

추가 리소스

- Red Hat Ceph Storage Operations Guide의 Ceph OSD 배포 목록 섹션을 참조하십시오.

6.8. OSD 배포를 위한 고급 서비스 사양 및 필터

OSD 유형의 서비스 사양은 디스크 속성을 사용하여 클러스터 레이아웃을 설명하는 방법입니다. 장치 이름 및 경로의 세부 사항을 파악하지 않고도 필요한 구성으로 OSD로 전환해야 하는 디스크를 Ceph에 알리는 추상적인 방법을 사용자에게 제공합니다. 각 장치와 각 호스트에 대해 yaml 파일 또는 json 파일을 정의합니다.

OSD 사양의 일반 설정

- service_type: 'osd': OSDS를 생성하려면 필수입니다.

- service_id: 원하는 서비스 이름 또는 ID를 사용합니다. OSD 세트는 사양 파일을 사용하여 생성됩니다. 이 이름은 모든 OSD를 함께 관리하고 Orchestrator 서비스를 나타내는 데 사용됩니다.

placement: OSD를 배포해야 하는 호스트를 정의하는 데 사용됩니다.

다음 옵션에서 사용할 수 있습니다.

- host_pattern: '*' - 호스트를 선택하는 데 사용되는 호스트 이름 패턴입니다.

- label: 'osd_host' - OSD를 배포해야 하는 호스트에서 사용되는 레이블입니다.

- hosts: 'host01', 'host02' - OSD를 배포해야 하는 호스트 이름의 명시적 목록입니다.

장치 선택: OSD가 생성되는 장치입니다. 이를 통해 OSD를 다른 장치와 분리할 수 있습니다. 다음 세 가지 구성 요소가 있는 BlueStore OSD만 생성할 수 있습니다.

- OSD data: 모든 OSD 데이터를 포함합니다.

- WAL: BlueStore 내부 저널 또는 쓰기 로그

- DB: BlueStore 내부 메타데이터

- data_devices: OSD를 배포할 장치를 정의합니다. 이 경우 OSD는 배치된 스키마로 생성됩니다. 필터를 사용하여 장치 및 폴더를 선택할 수 있습니다.

- wal_devices: WAL OSD에 사용되는 장치를 정의합니다. 필터를 사용하여 장치 및 폴더를 선택할 수 있습니다.

- db_devices: DB OSD의 장치를 정의합니다. 필터를 사용하여 장치 및 폴더를 선택할 수 있습니다.

-

encrypted:

True또는False로 설정할 수 있는 OSD에 대한 정보를 암호화하는 선택적 매개변수입니다. - Unmanaged: 기본적으로 False로 설정된 선택적 매개변수입니다. Orchestrator가 OSD 서비스를 관리하지 않으려면 True로 설정할 수 있습니다.

- block_wal_size: 사용자 정의 값(바이트)입니다.

- block_db_size: 사용자 정의 값(바이트)입니다.

- osds_per_device: 장치당 두 개 이상의 OSD를 배포하기 위한 사용자 정의 값입니다.

-

메서드: OSD가 LVM 계층으로 생성되었는지 여부를 지정하는 선택적 매개변수입니다. LVM 계층을 포함하지 않는 원시 물리적 장치에서 OSD를 생성하려면

raw로 설정합니다. DB 또는 WAL 장치가 별도의 경우 블록 대 DB 또는 WAL 장치의 비율은 1:1 이어야합니다.

장치 지정을 위한 필터

필터는 data_devices,wal_devices 및 db_devices 매개변수와 함께 사용됩니다.

| 필터의 이름 | 설명 | 구문 | 예제 |

| 모델 |

특정 디스크를 대상으로 합니다. | Model: DISK_MODEL_NAME | 모델: MC-55-44-XZ |

| vendor | 대상 특정 디스크 | vendor: DISK_VENDOR_NAME | 공급 업체: 벤더 Cs |

| 크기 사양 | 정확한 크기의 디스크 포함 | 크기: EXACT | 크기: '10G' |

| 크기 사양 | 범위 내에 있는 디스크 크기 포함 | 크기: LOW:HIGH | 크기: '10G:40G' |

| 크기 사양 | 크기보다 작거나 같은 디스크 포함 | 크기 :HIGH | 크기: ':10G' |

| 크기 사양 | 크기와 같거나 큰 디스크 포함 | 크기: LOW: | 크기: '40G:' |

| rotational | 디스크의 rotational 속성입니다. 1 rotational인 모든 디스크와 일치하고 0은 순환되지 않은 모든 디스크와 일치합니다. rotational =0인 경우 OSD는 SSD 또는 NVME로 구성됩니다. rotational=1인 경우 OSD는 HDD로 구성됩니다. | rotational: 0 또는 1 | rotational: 0 |

| All | 사용 가능한 모든 디스크 고려 | 모두: true | 모두: true |

| Limiter | 유효한 필터를 지정했지만 일치하는 디스크의 양을 제한하려면 'limit' 지시문을 사용할 수 있습니다. 마지막 수단으로만 사용해야 합니다. | 제한: NUMBER | 제한: 2 |

동일한 호스트에 배치되지 않은 구성 요소가 있는 OSD를 생성하려면 사용되는 다양한 유형의 장치를 지정해야 하며 장치가 동일한 호스트에 있어야 합니다.

OSD 배포에 사용되는 장치는 libstoragemgmt 에서 지원해야 합니다.

추가 리소스

- Red Hat Ceph Storage Operations Guide의 고급 사양 섹션을 사용하여 Ceph OSD 배포 섹션을 참조하십시오.

-

libstoragemgmt에 대한 자세한 내용은 Red Hat Ceph Storage Operations Guide의 Ceph OSD 배포 목록 섹션을 참조하십시오.

6.9. 고급 서비스 사양을 사용하여 Ceph OSD 배포

OSD 유형의 서비스 사양은 디스크 속성을 사용하여 클러스터 레이아웃을 설명하는 방법입니다. 장치 이름 및 경로의 세부 사항을 파악하지 않고도 필요한 구성으로 OSD로 전환해야 하는 디스크를 Ceph에 알리는 추상적인 방법을 사용자에게 제공합니다.

yaml 파일 또는 json 파일을 정의하여 각 장치 및 각 호스트에 대해 OSD를 배포할 수 있습니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 호스트가 클러스터에 추가됩니다.

- 모든 관리자 및 모니터 데몬이 배포됩니다.

프로세스

모니터 노드에서

osd_spec.yaml파일을 생성합니다.예제

[root@host01 ~]# touch osd_spec.yaml

다음 세부 정보를 포함하도록

osd_spec.yaml파일을 편집합니다.구문

service_type: osd service_id: SERVICE_ID placement: host_pattern: '*' # optional data_devices: # optional model: DISK_MODEL_NAME # optional paths: - /DEVICE_PATH osds_per_device: NUMBER_OF_DEVICES # optional db_devices: # optional size: # optional all: true # optional paths: - /DEVICE_PATH encrypted: true

간단한 시나리오: 이러한 경우 모든 노드에 동일한 설정이 있습니다.

예제

service_type: osd service_id: osd_spec_default placement: host_pattern: '*' data_devices: all: true paths: - /dev/sdb encrypted: true

예제

service_type: osd service_id: osd_spec_default placement: host_pattern: '*' data_devices: size: '80G' db_devices: size: '40G:' paths: - /dev/sdc

간단한 시나리오: 이 경우 모든 노드는 LVM 계층 없이 원시 모드에서 생성된 OSD 장치와 동일한 설정을 갖습니다.

예제

service_type: osd service_id: all-available-devices encrypted: "true" method: raw placement: host_pattern: "*" data_devices: all: "true"

고급 시나리오: 이 경우 전용 DB 또는 WAL 장치로 할당된 두 개의 SSD가 있는

data_devices를 모든 HDD를 사용하여 원하는 레이아웃을 생성합니다. 나머지 SSD는 NVMEs 공급업체가 전용 DB 또는 WAL 장치로 할당된data_devices입니다.예제

service_type: osd service_id: osd_spec_hdd placement: host_pattern: '*' data_devices: rotational: 0 db_devices: model: Model-name limit: 2 --- service_type: osd service_id: osd_spec_ssd placement: host_pattern: '*' data_devices: model: Model-name db_devices: vendor: Vendor-name

비균일 노드가 있는 고급 시나리오: host_pattern 키에 따라 다른 OSD 사양을 다른 호스트에 적용합니다.

예제

service_type: osd service_id: osd_spec_node_one_to_five placement: host_pattern: 'node[1-5]' data_devices: rotational: 1 db_devices: rotational: 0 --- service_type: osd service_id: osd_spec_six_to_ten placement: host_pattern: 'node[6-10]' data_devices: model: Model-name db_devices: model: Model-name

전용 WAL 및 DB 장치가 있는 고급 시나리오:

예제

service_type: osd service_id: osd_using_paths placement: hosts: - host01 - host02 data_devices: paths: - /dev/sdb db_devices: paths: - /dev/sdc wal_devices: paths: - /dev/sdd장치당 여러 OSD가 있는 고급 시나리오:

예제

service_type: osd service_id: multiple_osds placement: hosts: - host01 - host02 osds_per_device: 4 data_devices: paths: - /dev/sdb미리 생성된 볼륨의 경우 다음 세부 정보를 포함하도록

osd_spec.yaml파일을 편집합니다.구문

service_type: osd service_id: SERVICE_ID placement: hosts: - HOSTNAME data_devices: # optional model: DISK_MODEL_NAME # optional paths: - /DEVICE_PATH db_devices: # optional size: # optional all: true # optional paths: - /DEVICE_PATH

예제

service_type: osd service_id: osd_spec placement: hosts: - machine1 data_devices: paths: - /dev/vg_hdd/lv_hdd db_devices: paths: - /dev/vg_nvme/lv_nvmeID로 OSD의 경우 다음 세부 정보를 포함하도록

osd_spec.yaml파일을 편집합니다.참고이 구성은 Red Hat Ceph Storage 5.3z1 이상 릴리스에 적용할 수 있습니다. 이전 릴리스에서는 사전 생성된 lvm을 사용합니다.

구문

service_type: osd service_id: OSD_BY_ID_HOSTNAME placement: hosts: - HOSTNAME data_devices: # optional model: DISK_MODEL_NAME # optional paths: - /DEVICE_PATH db_devices: # optional size: # optional all: true # optional paths: - /DEVICE_PATH

예제

service_type: osd service_id: osd_by_id_host01 placement: hosts: - host01 data_devices: paths: - /dev/disk/by-id/scsi-0QEMU_QEMU_HARDDISK_drive-scsi0-0-0-5 db_devices: paths: - /dev/disk/by-id/nvme-nvme.1b36-31323334-51454d55204e564d65204374726c-00000001경로별로 OSD의 경우 다음 세부 정보를 포함하도록

osd_spec.yaml파일을 편집합니다.참고이 구성은 Red Hat Ceph Storage 5.3z1 이상 릴리스에 적용할 수 있습니다. 이전 릴리스에서는 사전 생성된 lvm을 사용합니다.

구문

service_type: osd service_id: OSD_BY_PATH_HOSTNAME placement: hosts: - HOSTNAME data_devices: # optional model: DISK_MODEL_NAME # optional paths: - /DEVICE_PATH db_devices: # optional size: # optional all: true # optional paths: - /DEVICE_PATH

예제

service_type: osd service_id: osd_by_path_host01 placement: hosts: - host01 data_devices: paths: - /dev/disk/by-path/pci-0000:0d:00.0-scsi-0:0:0:4 db_devices: paths: - /dev/disk/by-path/pci-0000:00:02.0-nvme-1

YAML 파일을 컨테이너의 디렉터리에 마운트합니다.

예제

[root@host01 ~]# cephadm shell --mount osd_spec.yaml:/var/lib/ceph/osd/osd_spec.yaml

디렉터리로 이동합니다.

예제

[ceph: root@host01 /]# cd /var/lib/ceph/osd/

OSD를 배포하기 전에 예행 실행을 수행합니다.

참고이 단계에서는 데몬을 배포하지 않고 배포 프리뷰를 제공합니다.

예제

[ceph: root@host01 osd]# ceph orch apply -i osd_spec.yaml --dry-run

서비스 사양을 사용하여 OSD를 배포합니다.

구문

ceph orch apply -i FILE_NAME.yml예제

[ceph: root@host01 osd]# ceph orch apply -i osd_spec.yaml

검증

서비스를 나열합니다.

예제

[ceph: root@host01 /]# ceph orch ls osd

노드 및 장치의 세부 정보를 확인합니다.

예제

[ceph: root@host01 /]# ceph osd tree

추가 리소스

- Red Hat Ceph Storage Operations Guide 의 OSD 배포 섹션은 고급 서비스 사양 및 필터 를 참조하십시오.

6.10. Ceph Orchestrator를 사용하여 OSD 데몬 제거

Cephadm을 사용하여 클러스터에서 OSD를 제거할 수 있습니다.

클러스터에서 OSD를 제거하려면 다음 두 단계가 필요합니다.

- 클러스터에서 모든 배치 그룹(PG)을 비웁니다.

- 클러스터에서 PG가 없는 OSD를 제거합니다.

--zap 옵션은 볼륨 그룹, 논리 볼륨 및 LVM 메타데이터를 제거했습니다.

OSD를 제거한 후 OSD를 다시 사용할 수 있게 되면 기존 drivegroup 사양과 일치하는 경우 cephadm' 이 자동으로 이러한 드라이브에 더 많은 OSD를 배포하려고 할 수 있습니다. 사양으로 제거 중인 OSD를 배포하고 제거 후 드라이브에 새 OSD를 배포하지 않으려면 제거 전에 drivegroup 사양을 수정합니다. OSD를 배포하는 동안 --all-available-devices 옵션을 사용한 경우 unmanaged: true 를 설정하여 새 드라이브를 전혀 선택하지 않도록 합니다. 기타 배포의 경우 사양을 수정합니다. 자세한 내용은 고급 서비스 사양을 사용하여 Ceph OSD 배포를 참조하십시오.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 호스트가 클러스터에 추가됩니다.

- Ceph Monitor, Ceph Manager 및 Ceph OSD 데몬은 스토리지 클러스터에 배포됩니다.

프로세스

Cephadm 쉘에 로그인합니다.

예제

[root@host01 ~]# cephadm shell

OSD를 제거해야 하는 장치 및 노드를 확인합니다.

예제

[ceph: root@host01 /]# ceph osd tree

OSD를 제거합니다.

구문

ceph orch osd rm OSD_ID [--replace] [--force] --zap예제

[ceph: root@host01 /]# ceph orch osd rm 0 --zap

참고--replace와 같은 옵션 없이 스토리지 클러스터에서 OSD를 제거하면 스토리지 클러스터에서 장치가 완전히 제거됩니다. OSD 배포에 동일한 장치를 사용하려면 먼저 장치 zap을 스토리지 클러스터에 추가해야 합니다.선택 사항: 특정 노드에서 여러 OSD를 제거하려면 다음 명령을 실행합니다.

구문

ceph orch osd rm OSD_ID OSD_ID --zap

예제

[ceph: root@host01 /]# ceph orch osd rm 2 5 --zap

OSD 제거 상태를 확인합니다.

예제

[ceph: root@host01 /]# ceph orch osd rm status OSD HOST STATE PGS REPLACE FORCE ZAP DRAIN STARTED AT 9 host01 done, waiting for purge 0 False False True 2023-06-06 17:50:50.525690 10 host03 done, waiting for purge 0 False False True 2023-06-06 17:49:38.731533 11 host02 done, waiting for purge 0 False False True 2023-06-06 17:48:36.641105

OSD에 PG가 남아 있지 않으면 클러스터에서 해제되고 제거됩니다.

검증

Ceph OSD가 제거된 장치 및 노드의 세부 정보를 확인합니다.

예제

[ceph: root@host01 /]# ceph osd tree

추가 리소스

- 자세한 내용은 Red Hat Ceph Storage Operations Guide의 사용 가능한 모든 장치에 Ceph OSD 배포 섹션을 참조하십시오.

- 자세한 내용은 Red Hat Ceph Storage Operations Guide의 특정 장치 및 호스트에 Ceph OSD 배포 섹션을 참조하십시오.

- 장치의 공간 지우기에 대한 자세한 내용은 Red Hat Ceph Storage Operations Guide 의 Ceph OSD 배포 Zapping devices 섹션을 참조하십시오.

6.11. Ceph Orchestrator를 사용하여 OSD 교체

디스크가 실패하면 물리적 스토리지 장치를 교체하고 동일한 OSD ID를 재사용하여 CRUSH 맵을 재구성할 필요가 없습니다.

--replace 옵션을 사용하여 클러스터의 OSD를 교체할 수 있습니다.

단일 OSD를 교체하려면 특정 장치 및 호스트에 Ceph OSD 배포를 참조하십시오. 사용 가능한 모든 장치에 OSD를 배포하려면 사용 가능한 모든 장치에 Ceph OSD 배포를 참조하십시오.

이 옵션은 ceph orch rm 명령을 사용하여 OSD ID를 유지합니다. OSD는 CRUSH 계층에서 영구적으로 제거되지 않지만 삭제 플래그가 할당됩니다. 이 플래그는 다음 OSD 배포에서 재사용할 수 있는 OSD ID를 결정하는 데 사용됩니다. 삭제된 플래그는 다음 OSD 배포에서 재사용되는 OSD ID를 결정하는 데 사용됩니다.

rm 명령과 유사하게 클러스터에서 OSD를 교체하려면 다음 두 단계가 필요합니다.

- 클러스터에서 모든 배치 그룹(PG)을 비웁니다.

- 클러스터에서 PG가 없는 OSD 제거.

배포에 OSD 사양을 사용하는 경우 새로 추가된 디스크에 교체된 항목의 OSD ID가 할당됩니다.

OSD를 제거한 후 드라이브가 다시 사용 가능하게 되면 OSD가 다시 사용 가능하게 되면 기존 drivegroup 사양과 일치하는 경우 cephadm 에서 이러한 드라이브에 더 많은 OSD를 자동으로 배포할 수 있습니다. 사양으로 제거 중인 OSD를 배포하고 제거 후 드라이브에 새 OSD를 배포하지 않으려면 제거 전에 drivegroup 사양을 수정합니다. OSD를 배포하는 동안 --all-available-devices 옵션을 사용한 경우 unmanaged: true 를 설정하여 새 드라이브를 전혀 선택하지 않도록 합니다. 기타 배포의 경우 사양을 수정합니다. 자세한 내용은 고급 서비스 사양을 사용하여 Ceph OSD 배포를 참조하십시오.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 호스트가 클러스터에 추가됩니다.

- 모니터, 관리자 및 OSD 데몬은 스토리지 클러스터에 배포됩니다.

- 제거된 OSD를 대체하는 새 OSD는 OSD가 제거된 동일한 호스트에서 생성해야 합니다.

프로세스

Cephadm 쉘에 로그인합니다.

예제

[root@host01 ~]# cephadm shell

향후 참조를 위해 OSD 구성 매핑을 덤프하고 저장해야 합니다.

예제

[ceph: root@node /]# ceph osd metadata -f plain | grep device_paths "device_paths": "sde=/dev/disk/by-path/pci-0000:03:00.0-scsi-0:0:0:1,sdi=/dev/disk/by-path/pci-0000:03:00.0-scsi-0:1:0:1", "device_paths": "sde=/dev/disk/by-path/pci-0000:03:00.0-scsi-0:0:0:1,sdf=/dev/disk/by-path/pci-0000:03:00.0-scsi-0:1:0:1", "device_paths": "sdd=/dev/disk/by-path/pci-0000:03:00.0-scsi-0:0:0:2,sdg=/dev/disk/by-path/pci-0000:03:00.0-scsi-0:1:0:2", "device_paths": "sdd=/dev/disk/by-path/pci-0000:03:00.0-scsi-0:0:0:2,sdh=/dev/disk/by-path/pci-0000:03:00.0-scsi-0:1:0:2", "device_paths": "sdd=/dev/disk/by-path/pci-0000:03:00.0-scsi-0:0:0:2,sdk=/dev/disk/by-path/pci-0000:03:00.0-scsi-0:1:0:2", "device_paths": "sdc=/dev/disk/by-path/pci-0000:03:00.0-scsi-0:0:0:3,sdl=/dev/disk/by-path/pci-0000:03:00.0-scsi-0:1:0:3", "device_paths": "sdc=/dev/disk/by-path/pci-0000:03:00.0-scsi-0:0:0:3,sdj=/dev/disk/by-path/pci-0000:03:00.0-scsi-0:1:0:3", "device_paths": "sdc=/dev/disk/by-path/pci-0000:03:00.0-scsi-0:0:0:3,sdm=/dev/disk/by-path/pci-0000:03:00.0-scsi-0:1:0:3", [.. output omitted ..]

OSD를 교체해야 하는 장치 및 노드를 확인합니다.

예제

[ceph: root@host01 /]# ceph osd tree

OSD를 교체합니다.

중요스토리지 클러스터에

health_warn또는 기타 오류가 연결된 경우 OSD를 교체하기 전에 오류를 확인하고 수정하여 데이터 손실을 방지합니다.구문

ceph orch osd rm OSD_ID --replace [--force]스토리지 클러스터에 지속적인 작업이 있는 경우

--force옵션을 사용할 수 있습니다.예제

[ceph: root@host01 /]# ceph orch osd rm 0 --replace

OSD 교체 상태를 확인합니다.

예제

[ceph: root@host01 /]# ceph orch osd rm status

오케스트레이터를 중지하여 기존 OSD 사양을 적용합니다.

예제

[ceph: root@node /]# ceph orch pause [ceph: root@node /]# ceph orch status Backend: cephadm Available: Yes Paused: Yes

제거된 OSD 장치를 zap합니다.

예제

[ceph: root@node /]# ceph orch device zap node.example.com /dev/sdi --force zap successful for /dev/sdi on node.example.com [ceph: root@node /]# ceph orch device zap node.example.com /dev/sdf --force zap successful for /dev/sdf on node.example.com

일시 중지 모드에서 Orcestrator를 다시 시작

예제

[ceph: root@node /]# ceph orch resume

OSD 교체 상태를 확인합니다.

예제

[ceph: root@node /]# ceph osd tree ID CLASS WEIGHT TYPE NAME STATUS REWEIGHT PRI-AFF -1 0.77112 root default -3 0.77112 host node 0 hdd 0.09639 osd.0 up 1.00000 1.00000 1 hdd 0.09639 osd.1 up 1.00000 1.00000 2 hdd 0.09639 osd.2 up 1.00000 1.00000 3 hdd 0.09639 osd.3 up 1.00000 1.00000 4 hdd 0.09639 osd.4 up 1.00000 1.00000 5 hdd 0.09639 osd.5 up 1.00000 1.00000 6 hdd 0.09639 osd.6 up 1.00000 1.00000 7 hdd 0.09639 osd.7 up 1.00000 1.00000 [.. output omitted ..]

검증

Ceph OSD가 교체되는 장치 및 노드의 세부 정보를 확인합니다.

예제

[ceph: root@host01 /]# ceph osd tree

동일한 호스트에서 실행 중인 것과 동일한 ID가 있는 OSD를 확인할 수 있습니다.

새로 배포된 OSD의

db_device가 교체된db_device인지 확인합니다.예제

[ceph: root@host01 /]# ceph osd metadata 0 | grep bluefs_db_devices "bluefs_db_devices": "nvme0n1", [ceph: root@host01 /]# ceph osd metadata 1 | grep bluefs_db_devices "bluefs_db_devices": "nvme0n1",

추가 리소스