Red Hat Training

A Red Hat training course is available for Red Hat Enterprise Linux

仮想化管理ガイド

仮想環境の管理

概要

第1章 サーバーのベストプラクティス

- SELinux を Enforcing モードで実行します。setenforce コマンドを使用して、SELinux が Enforcing モードで実行するように設定します。

# setenforce 1

- AutoFS、NFS、FTP、HTTP、NIS、telnetd、sendmail などの不要なサービスを削除または無効にします。

- サーバー上にはプラットフォームの管理に必要な最低限のユーザーアカウントのみを追加します。不要なユーザーアカウントは削除してください。

- ホストでは不必要なアプリケーションは実行しないようにしてください。ホストでアプリケーションを実行すると仮想マシンのパフォーマンスに影響を与えるため、その影響がサーバーの安定性に及ぶ可能性があります。サーバーがクラッシュする可能性のあるアプリケーションでも、サーバー上のすべての仮想マシンがダウンします。

- 仮想マシンのインストールおよびイメージには集中管理できる場所を使用します。仮想マシンのイメージは

/var/lib/libvirt/images/に格納します。仮想マシンのイメージをこれ以外のディレクトリーに格納する場合は、そのディレクトリーを SELinux ポリシーに追加し、インストールを開始する前にラベルの再設定を必ず行ってください。集中管理ができる共有可能なネットワークストレージの使用を強くお勧めします。

第2章 sVirt

非仮想化環境

非仮想化環境では、ホスト物理マシンは互いに物理的に分離されており、各ホスト物理マシンには、Web サーバーや DNS サーバーなどのサービスで設定される自己完結型の環境があります。これらのサービスは、独自のユーザー空間、ホストの物理マシンのカーネルおよび物理ハードウェアに直接通信し、サービスをネットワークに直接提供します。以下のイメージは、仮想化されていない環境を表しています。

- ??????

- ユーザー空間: 全ユーザーモードのアプリケーションと一部のドライバーが実行されるメモリー領域。

- ???

- Web アプリ (Web アプリケーションサーバー): ブラウザーからアクセスできる Web コンテンツを配信します。

- ??????

- ホストカーネル: ホストの物理マシンの特権付きカーネル、カーネル拡張、およびほとんどのデバイスドライバーを実行するために厳密に予約されます。

- ???

- DNS サーバー: DNS レコードを格納し、ユーザーが IP アドレスの代わりに論理名を使用して Web ページにアクセスできるようにします。

仮想化環境

仮想化環境では、複数の仮想オペレーティングシステムを、ホスト物理マシン上にある単一のカーネルで実行できます。以下のイメージは、仮想化環境を表しています。

2.1. セキュリティーおよび仮想化

2.2. sVirt のラベル付け

# ps -eZ | grep qemu system_u:system_r:svirt_t:s0:c87,c520 27950 ? 00:00:17 qemu-kvm

# ls -lZ /var/lib/libvirt/images/* system_u:object_r:svirt_image_t:s0:c87,c520 image1

表2.1 sVirt コンテキストラベル

| SELinux コンテキスト | タイプ/説明 |

|---|---|

| system_u:system_r:svirt_t:MCS1 | ゲスト仮想マシンのプロセス。MCS1 はランダムな MCS フィールドです。約 500,000 個のラベルがサポートされます。 |

| system_u:object_r:svirt_image_t:MCS1 | ゲスト仮想マシンのイメージ。これらのイメージの読み取り/書き込みができるのは、同じ MCS フィールドを持つ svirt_t プロセスのみです。 |

| system_u:object_r:svirt_image_t:s0 | ゲスト仮想マシンの共有の読み取り/書き込みコンテンツ。すべての svirt_t プロセスは svirt_image_t:s0 ファイルに書き込むことができます。 |

第3章 仮想マシンのクローン作成

- クローン は、1 台の仮想マシンのインスタンスです。クローンを使用すると、同じ仮想マシンのネットワークを設定したり、別の宛先に配布したりできます。

- テンプレート は、クローン作成のソースとして使用するように設計された仮想マシンのインスタンスです。テンプレートから複数のクローンを作成し、各クローンにマイナーな変更を加えることができます。これは、この変更がシステムに与える影響を確認する際に役立ちます。

- プラットフォームレベルの情報および設定には、仮想化ソリューションが仮想マシンに割り当てたものが含まれます。例には、ネットワークインターフェイスカード (NIC) の数と、その MAC アドレスが含まれます。

- ゲストオペレーティングシステムレベル情報および設定には、仮想マシン内で設定されたものが含まれます。例には SSH 鍵が含まれます。

- アプリケーションレベル情報および設定には、仮想マシンにインストールされているアプリケーションで設定したものが含まれます。例には、アクティベーションコードおよび登録情報が含まれます。注記情報およびアプローチは各アプリケーションに固有のものであるため、本章には、アプリケーションレベルの削除に関する情報は記載されていません。

3.1. クローンを作成する仮想マシンの準備

手順3.1 クローンを作成する仮想マシンの準備

仮想マシンのセットアップ

- クローンまたはテンプレートに使用する仮想マシンを構築します。

- クローンに必要なソフトウェアをインストールします。

- オペレーティングシステムに一意でない設定を設定します。

- 固有でないアプリケーション設定を設定します。

ネットワーク設定を削除します。

- 以下のコマンドを使用して、永続的な udev ルールを削除します。

# rm -f /etc/udev/rules.d/70-persistent-net.rules

注記udev ルールを削除しない場合は、最初の NIC の名前が eth0 ではなく eth1 になります。 /etc/sysconfig/network-scripts/ifcfg-eth[x]で以下の編集を行い、ifcfg スクリプトから一意のネットワークの詳細を削除します。- HWADDR 行および Static 行を削除します。注記HWADDR が新しいゲストの MAC アドレスと一致しない場合、ifcfg は無視されます。したがって、ファイルから HWADDR を削除することが重要です。

DEVICE=eth[x] BOOTPROTO=none ONBOOT=yes #NETWORK=10.0.1.0 <- REMOVE #NETMASK=255.255.255.0 <- REMOVE #IPADDR=10.0.1.20 <- REMOVE #HWADDR=xx:xx:xx:xx:xx <- REMOVE #USERCTL=no <- REMOVE # Remove any other *unique* or non-desired settings, such as UUID.

- HWADDR または一意の情報が含まれていない DHCP 設定が残っていることを確認します。

DEVICE=eth[x] BOOTPROTO=dhcp ONBOOT=yes

- ファイルに以下の行が含まれていることを確認します。

DEVICE=eth[x] ONBOOT=yes

- 以下のファイルが存在する場合は、そのファイルに同じ内容が含まれていることを確認してください。

/etc/sysconfig/networking/devices/ifcfg-eth[x]/etc/sysconfig/networking/profiles/default/ifcfg-eth[x]

注記NetworkManager または特殊な設定を仮想マシンで使用した場合は、追加の固有情報が ifcfg スクリプトから削除されていることを確認してください。

登録の詳細を削除します。

- 以下のいずれかを使用して、登録の詳細を削除します。

- Red Hat Network (RHN) 登録済みゲスト仮想マシンの場合は、以下のコマンドを実行します。

# rm /etc/sysconfig/rhn/systemid - Red Hat Subscription Manager (RHSM) の登録済みゲスト仮想マシンの場合は、次のコマンドを使用します。

- 元の仮想マシンを使用しない場合は、以下のコマンドを実行します。

# subscription-manager unsubscribe --all # subscription-manager unregister # subscription-manager clean

- 元の仮想マシンを使用する場合は、次のコマンドのみを実行します。

# subscription-manager clean注記元の RHSM プロファイルはポータルに残ります。

その他の固有の詳細の削除

- 次のコマンドを使用して、sshd の公開鍵と秘密鍵のペアを削除します。

# rm -rf /etc/ssh/ssh_host_*注記ssh キーを削除すると、このホストを信頼しない ssh クライアントの問題が回避されます。 - 複数のマシンで実行している場合に、競合する可能性があるその他のアプリケーション固有の識別子や設定を削除します。

次回のシステムの起動時に設定ウィザードを実行するように仮想マシンを設定します。

- 以下のいずれかの方法で、仮想マシンを次回起動したときに、関連する設定ウィザードが実行されるように設定します。

- Red Hat Enterprise Linux 6 以前の場合は、以下のコマンドを使用して、root ファイルシステムに .unconfigured という名前の空のファイルを作成します。

# touch /.unconfigured - Red Hat Enterprise Linux 7 の場合は、次のコマンドを実行して、最初の起動ウィザードおよび初期設定ウィザードを有効にします。

# sed -ie 's/RUN_FIRSTBOOT=NO/RUN_FIRSTBOOT=YES/' /etc/sysconfig/firstboot # systemctl enable firstboot-graphical # systemctl enable initial-setup-graphical

注記次回の起動時に実行するウィザードは、仮想マシンから削除された設定によって異なります。また、クローンの初回ブートでは、ホスト名を変更することが推奨されます。

3.2. 仮想マシンのクローン作成

3.2.1. virt-clone を使用したゲストのクローン作成

--orginal のみが必要です。オプションの一覧を表示するには、次のコマンドを実行します。

# virt-clone --help例3.1 virt-clone を使用したゲストのクローン作成

# virt-clone --original demo --auto-clone例3.2 virt-clone を使用したゲストのクローン作成

# virt-clone --connect qemu:///system --original demo --name newdemo --file /var/lib/xen/images/newdemo.img --file /var/lib/xen/images/newdata.img3.2.2. virt-manager を使用したゲストのクローン作成

手順3.2 virt-manager を使用した仮想マシンのクローンの作成

virt-manager を開く

virt-manager を起動します。Applications メニューおよび System Tools サブメニューから Virtual Machine Manager アプリケーションを起動します。または、root で virt-manager を実行します。Virtual Machine Manager にあるゲスト仮想マシンの一覧から、クローンを作成するゲスト仮想マシンを選択します。クローンを作成するゲスト仮想マシンを右クリックし、Clone を選択します。Clone Virtual Machine ウィンドウが開きます。図3.1 Clone Virtual Machine ウィンドウ

クローンの設定

- クローンの名前を変更する場合は、クローンの新しい名前を入力します。

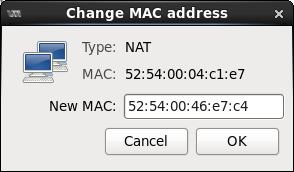

- ネットワーク設定を変更する場合は、Details を選択します。クローンの新しい MAC アドレスを入力します。OK をクリックします。

図3.2 Change MAC Address ウィンドウ

- クローンを作成したゲスト仮想マシンのディスクごとに、次のいずれかのオプションを選択します。

Clone this disk- ディスクは、クローンとして作成されたゲスト仮想マシンのクローンとして作成されます。Share disk with guest virtual machine name- ディスクは、クローンを作成されるゲスト仮想マシンとそのクローンで共有されます。Details- ストレージパスの変更 画面を開きます。これにより、ディスクへの新しいパスの選択が可能になります。図3.3 Change

storage pathウィンドウ

ゲスト仮想マシンのクローンを作成する

Clone をクリックします。

第4章 KVM のライブマイグレーション

- 負荷分散: ゲスト仮想マシンは、ホスト物理マシンが過負荷になった場合、または別のホスト物理マシンが十分に活用されていない場合に、使用率の低いホスト物理マシンに移動できます。

- ハードウェア独立性: ホストの物理マシンでハードウェアデバイスをアップグレード、追加、または削除する必要がある場合、ゲスト仮想マシンを他のホストの物理マシンに安全に移動できます。つまり、ゲスト仮想マシンでは、ハードウェアの改善のためのダウンタイムが発生しません。

- 省エネ: ゲスト仮想マシンを他のホスト物理マシンに再配布できるため、電源をオフにして、低使用期間でエネルギーを節約し、コストを削減できます。

- 地理的な移行: 待ち時間を短縮するため、または深刻な状況では、ゲスト仮想マシンを別の場所に移動できます。

4.1. ライブマイグレーションの要件

移行の要件

- 次のいずれかのプロトコルを使用して、共有ストレージにインストールされたゲスト仮想マシン。

- ファイバーチャネルベースの LUN

- iSCSI

- FCoE

- NFS

- GFS2

- SCSI RDMA プロトコル (SCSI RCP) - Infiniband アダプターおよび 10GbE iWARP アダプターで使用されるブロックエクスポートプロトコル

- 移行プラットフォームおよびバージョンは、テーブル 表4.1「ライブマイグレーションの互換性」 に対して確認する必要があります。また、Red Hat Enterprise Linux 6 は、共有ストレージ上の raw イメージと qcow2 イメージを使用したゲスト仮想マシンのライブマイグレーションをサポートしていることにも注意してください。

- 両方のシステムで、適切な TCP/IP ポートが開いている必要があります。ファイアウォールが使用されている場合は、詳細なポート情報の https://access.redhat.com/site/documentation/ で見つかる 『Red Hat Enterprise Linux Virtualization セキュリティーガイド』 を参照してください。

- 共有ストレージメディアをエクスポートする別のシステム。ストレージは、移行に使用される 2 つのホストマシンのいずれかに配置しないでください。

- 共有ストレージは、移行元システムと移行先システムの同じ場所にマウントする必要があります。マウントするディレクトリー名は同じである必要があります。別のパスを使用してイメージを保持することもできますが、推奨されません。virt-manager を使用して移行を行う場合は、パス名が同じである必要があることに注意してください。ただし、virsh を使用して移行を実行する場合は、移行を実行するときに --xml オプションまたはプリフックを使用して、さまざまなネットワーク設定とマウントディレクトリーを使用できます。共有ストレージがなくても、オプション --copy-storage-all (非推奨) を使用して移行を成功させることができます。prehooks の詳細は、 libvirt.org を参照してください。XML オプションの詳細については、20章ドメイン XML の操作 を参照してください。

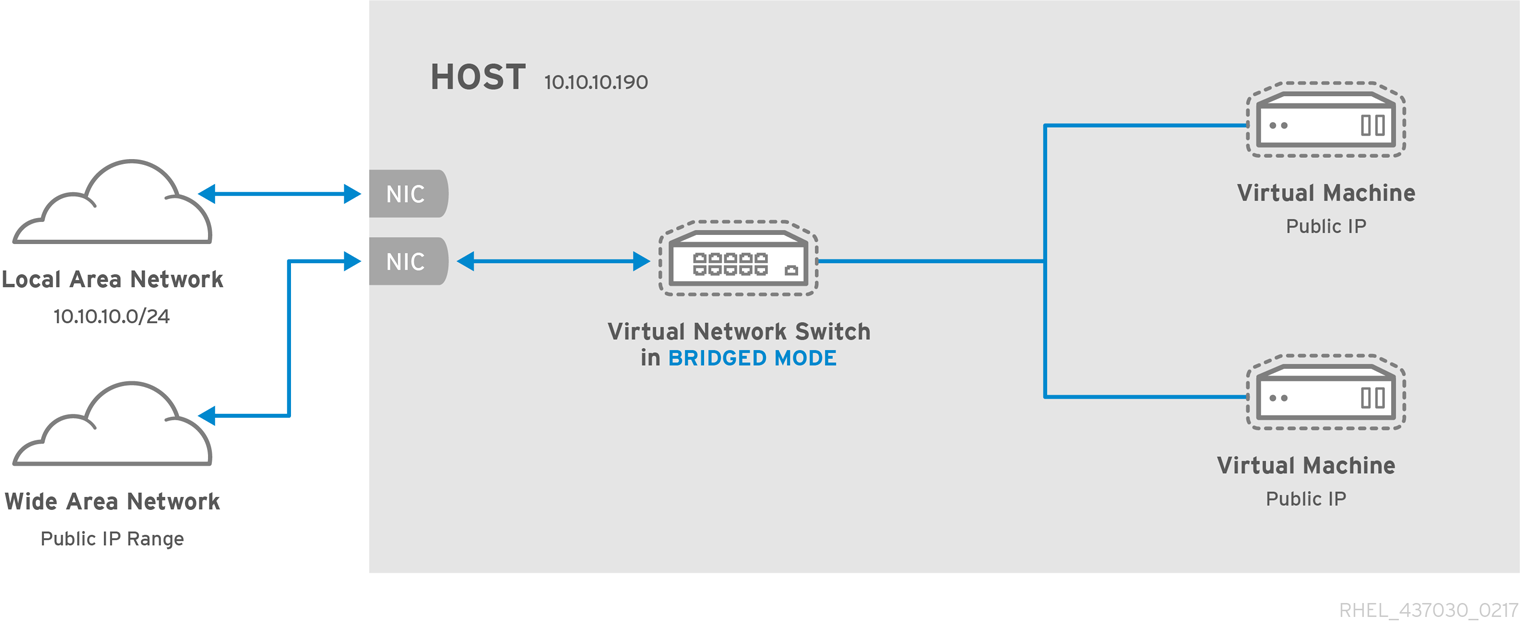

- パブリックブリッジ + タップネットワーク内の既存のゲスト仮想マシンで移行を試みる場合、移行元と移行先のホスト物理マシンは同じネットワークに配置する必要があります。この手順を行わないと、ゲストの仮想マシンネットワークが移行後に動作しません。

- Red Hat Enterprise Linux 5 および 6 では、KVM ゲスト仮想マシンのデフォルトのキャッシュモードが

noneに設定されているため、ディスクの状態に一貫性がありません。キャッシュオプションをnone(たとえば、virsh attach-disk cache none を使用) に設定すると、O_DIRECTフラグを使用してゲスト仮想マシンのファイルが開かれます (オープン システムコールを呼び出す場合)。つまり、ホストの物理マシンのキャッシュを回避し、ゲスト仮想マシンでキャッシュのみを提供します。キャッシュモードをnoneに設定すると、不整合の問題が回避され、使用すると、仮想マシンのライブマイグレーションが可能になります。キャッシュをnoneに設定する方法は、「ゲストへのストレージデバイスの追加」 を参照してください。

libvirtd サービスが有効になっていて (#chkconfig libvirtd on)、実行されている (#service libvirtd start) ことを確認してください。また、効果的に移行する機能は、/etc/libvirt/libvirtd.conf 設定ファイルのパラメーターの設定に依存することに注意してください。

手順4.1 libvirtd.conf の設定

libvirtd.confを開くには、root で次のコマンドを実行する必要があります。# vim /etc/libvirt/libvirtd.conf

- 必要に応じてパラメーターを変更し、ファイルを保存します。

libvirtdサービスを再起動します。# service libvirtd restart

4.2. ライブマイグレーションと Red Hat Enterprise Linux バージョンの互換性

表4.1 ライブマイグレーションの互換性

| 移行の方法 | リリースタイプ | 例 | ライブ移行のサポート | 注記 |

|---|---|---|---|---|

| 前方 | メジャーリリース | 5.x → 6.y | サポート対象外 | |

| 前方 | マイナーリリース | 5.x → 5.y (y>x, x>=4) | 完全対応 | 問題がある場合は報告する必要があります |

| 前方 | マイナーリリース | 6.x → 6.y (y>x, x>=0) | 完全対応 | 問題がある場合は報告する必要があります |

| 後方 | メジャーリリース | 6.x → 5.y | サポート対象外 | |

| 後方 | マイナーリリース | 5.x → 5.y (x>y,y>=4) | サポート対象 | 既知の問題は、移行に関する問題のトラブルシューティング を参照してください。 |

| 後方 | マイナーリリース | 6.x → 6.y (x>y, y>=0) | サポート対象 | 既知の問題は、移行に関する問題のトラブルシューティング を参照してください。 |

移行に関する問題のトラブルシューティング

- SPICE の問題: Red Hat Enterprise Linux 6.0→6.1 からの移行時に、SPICE に互換性のない変更があることが判明しました。このような場合、クライアントは切断してから再接続し、オーディオとビデオが一時的に失われる可能性があります。これは一時的なものであり、すべてのサービスが再開されます。

- USB の問題: Red Hat Enterprise Linux 6.2 は、移行サポートを含む USB 機能を追加しましたが、USB デバイスをリセットし、デバイス上で実行されているアプリケーションを中止させる特定の警告がないわけではありません。この問題は Red Hat Enterprise Linux 6.4 で修正され、今後のバージョンでは発生しません。6.4 よりも前のバージョンでこれが発生するのを防ぐには、USB デバイスが使用されている間は移行を行いません。

- 移行プロトコルの問題 - 後方移行が "unknown section error" で終了する場合は、一時的なエラーである可能性があるため、移行プロセスを繰り返すことで問題を修復できます。そうでない場合は、問題を報告してください。

ネットワークストレージの設定

共有ストレージを設定し、共有ストレージにゲスト仮想マシンをインストールします。

4.3. 共有ストレージの例: 単純な移行のための NFS

sync パラメーターが有効になっている必要もあります。これは、NFS ストレージを適切にエクスポートするために必要です。さらに、NFS をソースホスト物理マシンにマウントすることを強くお勧めします。ゲスト仮想マシンのイメージは、ソースホスト物理マシンにある NFS マウントディレクトリーに作成する必要があります。また、NFS ファイルロックは KVM でサポートされていないため、使用しないでください。

ディスクイメージ用のディレクトリーを作成します

この共有ディレクトリーには、ゲスト仮想マシンのディスクイメージが含まれます。これを行うには、/var/lib/libvirt/imagesとは異なる場所にディレクトリーを作成します。以下に例を示します。# mkdir /var/lib/libvirt-img/images

NFS 設定ファイルに新しいディレクトリーパスを追加します。

NFS 設定ファイルは、/etc/exportsにあるテキストファイルです。ファイルを開き、手順 1 で作成した新しいファイルへのパスを追加して編集します。# echo "/var/lib/libvirt-img/images" >> /etc/exports/[NFS-Config-FILENAME.txt]

NFS の起動

- iptable (2049 など) の NFS のポートが開いていることを確認し、

/etc/hosts.allowファイルに NFS を追加します。 - NFS サービスを開始します。

# service nfs start

ソースと宛先の両方に共有ストレージをマウントします

次のコマンドを 2 回実行して、ソースシステムと宛先システムの両方に/var/lib/libvirt/imagesディレクトリーをマウントします。ソースシステムで 1 回、宛先システムでもう一度。# mount

source_host:/var/lib/libvirt-img/images /var/lib/libvirt/images警告この手順で作成するディレクトリーが、「ライブマイグレーションの要件」 で概説されている要件に準拠していることを確認してください。さらに、ディレクトリーに正しい SELinux ラベルを付ける必要がある場合があります。詳細は、Red Hat Enterprise Linux ストレージ管理ガイド の NFS の章を参照してください。

4.4. virsh を使用した KVM のライブ移行

# virsh migrate --live GuestName DestinationURL-live オプションが削除される可能性があることに注意してください。追加オプションは、「virsh migrate コマンドの追加オプション」 に一覧表示されています。

GuestName パラメーターは、移行するゲスト仮想マシンの名前を表します。

DestinationURL パラメーターは、移行先ホストの物理マシンの接続 URL です。移行先システムで同じバージョンの Red Hat Enterprise Linux を実行し、同じハイパーバイザーを使用し、libvirt を実行している必要があります。

DestinationURL パラメーターには、以下のセマンティクスがあります。

- 通常の移行:

DestinationURLは、ソースゲスト仮想マシンから見たターゲットホスト物理マシンの URL です。 - ピアツーピアの移行:

DestinationURLは、移行元ホストの物理マシンから表示されるターゲットホストの物理マシンの URL です。

/etc/hosts ファイルに移行先ホストの物理マシンのエントリーが必要です。次の例に示すように、宛先ホストの物理マシンの IP アドレスとホスト名をこのファイルに入力し、宛先ホストの物理マシンの IP アドレスとホスト名を置き換えます。

10.0.0.20 host2.example.com

例:virsh を使用したライブマイグレーション

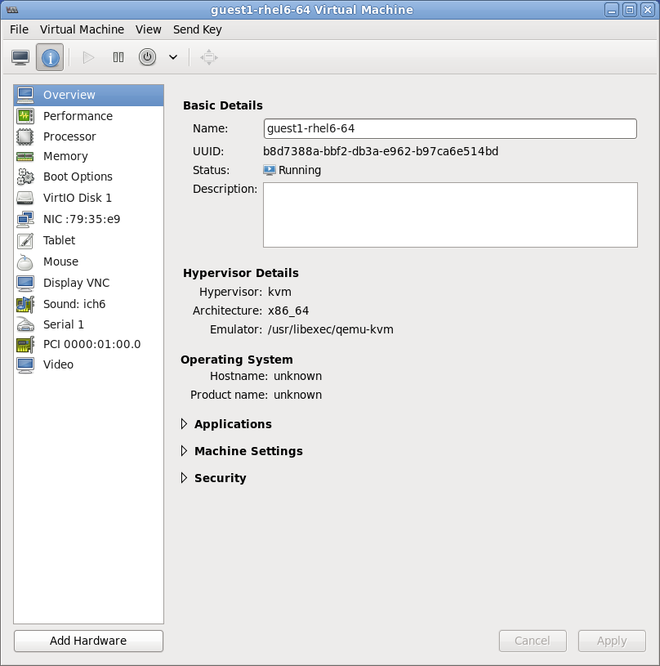

この例では、host1.example.com から host2.example.com に移行します。使用環境に合わせて、ホストの物理マシン名を変更します。この例では、guest1-rhel6-64 という名前の仮想マシンを移行します。

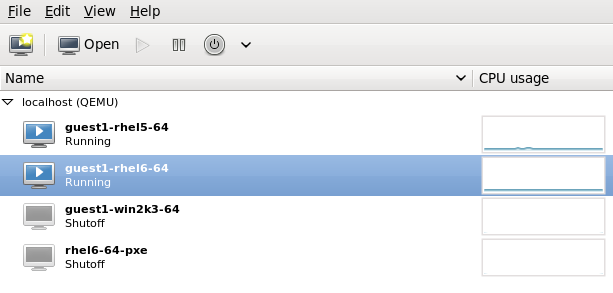

ゲスト仮想マシンが実行していることを確認します。

移行元システムで、host1.example.comを実行し、guest1-rhel6-64が実行していることを確認します。[root@host1 ~]# virsh list Id Name State ---------------------------------- 10 guest1-rhel6-64 running

ゲスト仮想マシンの移行

次のコマンドを実行して、ゲスト仮想マシンを移行先host2.example.comにライブ移行します。リンク先の URL の末尾に/systemを追加し、フルアクセスが必要であることを libvirt に指示します。# virsh migrate --live

guest1-rhel6-64 qemu+ssh://host2.example.com/systemコマンドを入力すると、インストール先システムの root パスワードを求められます。待機

負荷やゲスト仮想マシンのサイズによっては、移行に時間がかかる場合があります。virsh はエラーのみを報告します。ゲスト仮想マシンは、完全に移行するまで、移行元ホストの物理マシンで実行し続けます。注記移行中、完了率インジケーターの数は、プロセスが完了する前に複数回減少する可能性があります。これは、移行の開始後に変更されたソースメモリーページを再度コピーする必要があるため、全体的な進行状況の再計算が原因で発生します。したがって、この動作は予期されたものであり、移行に問題があることを示すものではありません。ゲスト仮想マシンが移行先ホストに到達していることを確認する

宛先システムhost2.example.comから、guest1-rhel6-64が実行されていることを確認します。[root@host2 ~]# virsh list Id Name State ---------------------------------- 10 guest1-rhel6-64 running

virsh dumpxml Guest1 > Guest1.xml virsh -c qemu+ssh://<target-system-FQDN> define Guest1.xml virsh undefine Guest1

4.4.1. virsh を使用した移行に関する追加のヒント

- 手順4.1「libvirtd.conf の設定」 の説明に従って、libvirtd.conf ファイルを開きます。

- Processing controls のセクションを探します。

################################################################# # # Processing controls # # The maximum number of concurrent client connections to allow # over all sockets combined. #max_clients = 20 # The minimum limit sets the number of workers to start up # initially. If the number of active clients exceeds this, # then more threads are spawned, upto max_workers limit. # Typically you'd want max_workers to equal maximum number # of clients allowed #min_workers = 5 #max_workers = 20 # The number of priority workers. If all workers from above # pool will stuck, some calls marked as high priority # (notably domainDestroy) can be executed in this pool. #prio_workers = 5 # Total global limit on concurrent RPC calls. Should be # at least as large as max_workers. Beyond this, RPC requests # will be read into memory and queued. This directly impact # memory usage, currently each request requires 256 KB of # memory. So by default upto 5 MB of memory is used # # XXX this isn't actually enforced yet, only the per-client # limit is used so far #max_requests = 20 # Limit on concurrent requests from a single client # connection. To avoid one client monopolizing the server # this should be a small fraction of the global max_requests # and max_workers parameter #max_client_requests = 5 #################################################################

max_clientsおよびmax_workersパラメーターの設定を変更します。両方のパラメーターの番号が同じであることが推奨されます。max_clientsは、移行ごとに 2 つのクライアント (各側に 1 つ) を使用します。max_workersは、実行フェーズ中に移行元で 1 つのワーカーと、移行先で 0 のワーカーを使用し、終了フェーズ中に移行先でワーカーを 1 つ使用します。重要max_clientsパラメーターおよびmax_workersパラメーターの設定は、libvirtd サービスへのゲスト仮想マシンのすべての接続の影響を受けます。つまり、同じゲスト仮想マシンを使用しているユーザーで、同時に移行を実行しているすべてのユーザーは、max_clientsおよびmax_workersパラメーター設定で設定される制限にも古いことになります。このため、同時ライブマイグレーションを実行する前に、最大値を慎重に検討する必要があります。- ファイルを保存し、サービスを再起動します。注記起動したにもかかわらず認証されていない ssh セッションが多すぎるために、移行接続が切断する場合があります。デフォルトでは、

sshdで許可されるセッションは 10 セッションのみで、常に "pre-authenticated state" となります。この設定は、sshd 設定ファイル (ここでは/etc/ssh/sshd_config) のMaxStartupsパラメーターで制御されます。これには調整が必要な場合があります。この制限は DoS 攻撃 (および一般的なリソースの過剰使用) を防ぐために設定されているため、このパラメーターの調整は慎重に行ってください。この値を高く設定しすぎると、目的が無効になります。このパラメーターを変更するには、ファイル/etc/ssh/sshd_configを変更し、MaxStartups 行の先頭から#を削除して、10(デフォルト値) をより大きな数値に変更します。必ず保存して、sshdサービスを再起動してください。詳細は、sshd_configの man ページを参照してください。

4.4.2. virsh migrate コマンドの追加オプション

--live のほかに、virsh migrate では以下のオプションを利用できます。

--direct- 直接移行に使用されます。--p2p- ピアツーピア移行に使用されます。--tunnelled- トンネル化された移行に使用されます。--persistent- ドメインを移行先ホストの物理マシンの永続状態に残します。--undefinesource- ソースホストの物理マシンのゲスト仮想マシンを削除します。--suspend- ドメインを移行先ホストの物理マシンの一時停止状態のままにします。--change-protection- 移行の進行中に、互換性のない設定変更がドメインに行われないように強制します。ハイパーバイザーによるサポートがある場合にこのオプションが暗黙的に有効になりますが、ハイパーバイザーに変更保護の対応がない場合に明示的に使用して移行を拒否できます。--unsafe- すべての安全手順を無視して、強制的に移行を実行します。--verbose- 移行の進行状況を表示します。--abort-on-error- 移行プロセス中にソフトエラー (I/O エラーなど) が発生すると移行を取り消します。--migrateuri: 通常省略される移行 URI です。--domain[string]- ドメイン名、ID、または uuid--desturi[string]: クライアント (通常の移行) またはソース (p2p 移行) から見た宛先ホスト物理マシンの接続 URI--migrateuri: 移行 URI。通常は省略できます。--timeout[seconds]- ライブマイグレーションカウンターが N 秒を超えるとゲスト仮想マシンを強制的に中断します。ライブマイグレーションでのみ使用できます。タイムアウトが開始されると、一時停止されたゲスト仮想マシンで移行が続行されます。--dname[string] - 移行時にゲスト仮想マシンの名前を新規の名前に変更します (サポートされている場合)。--xml- 指定されたファイル名を使用して、宛先で使用する別の XML ファイルを提供できます。このファイル名は、基となるストレージへのアクセスで、ソースと宛先の名前の相違を考慮するなど、ホスト固有のドメイン XML の部分にさらに多くの変更を加えます。このオプションは通常、省略されます。

4.5. virt-manager を使用した移行

virt-manager を開く

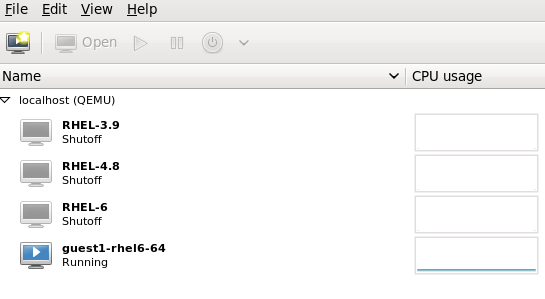

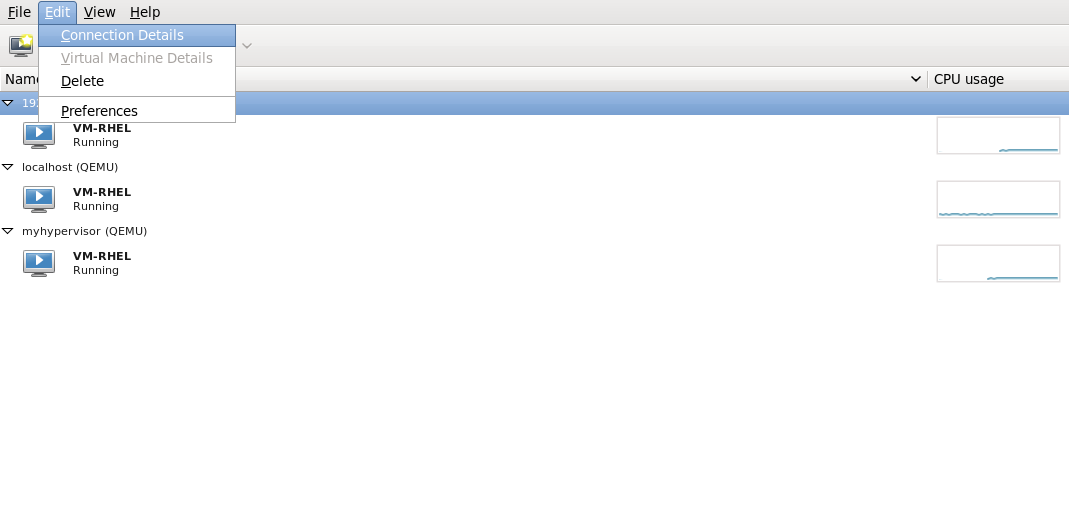

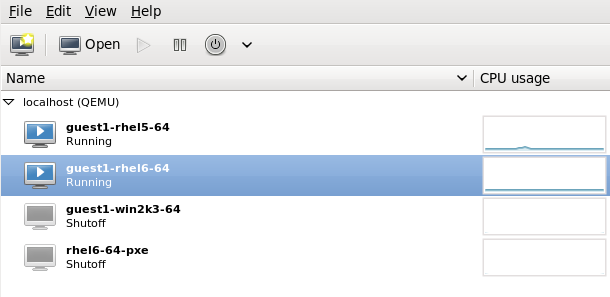

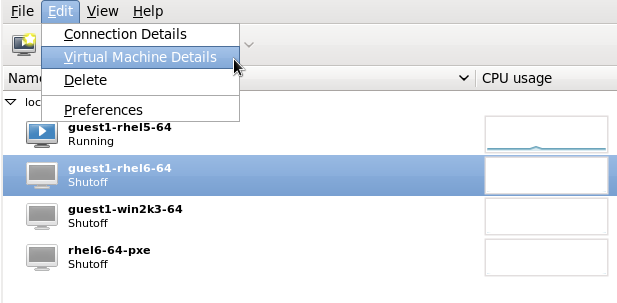

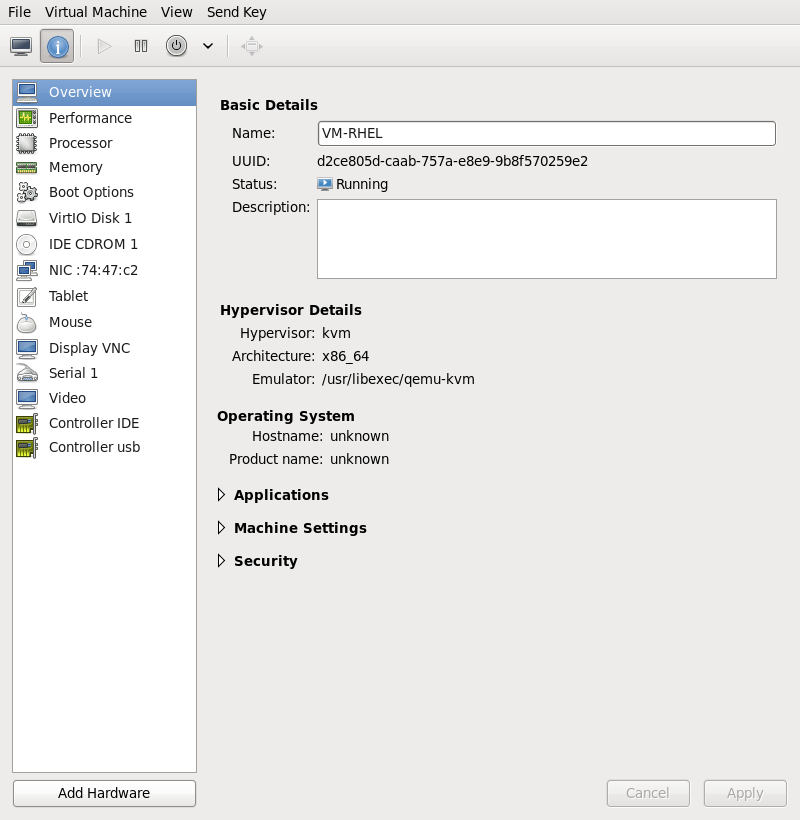

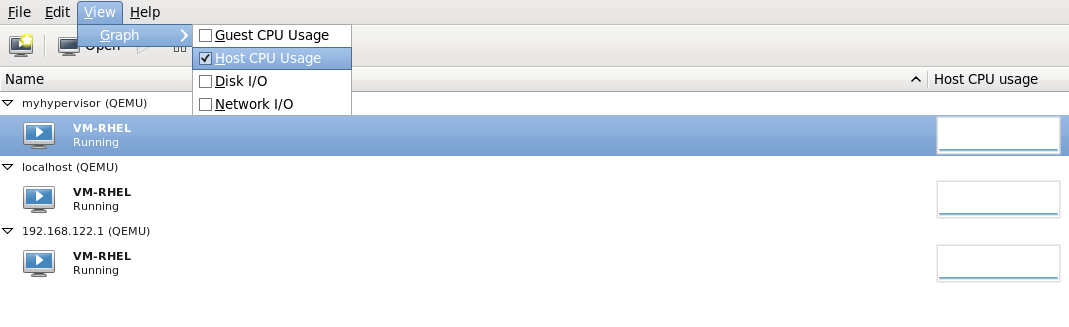

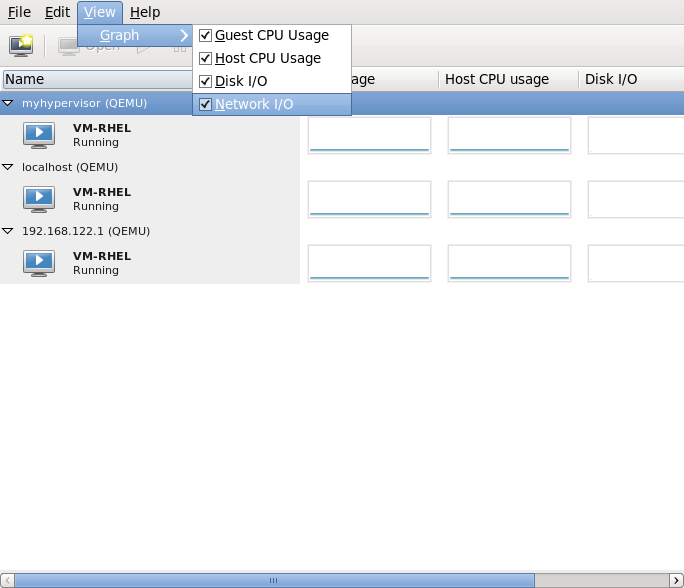

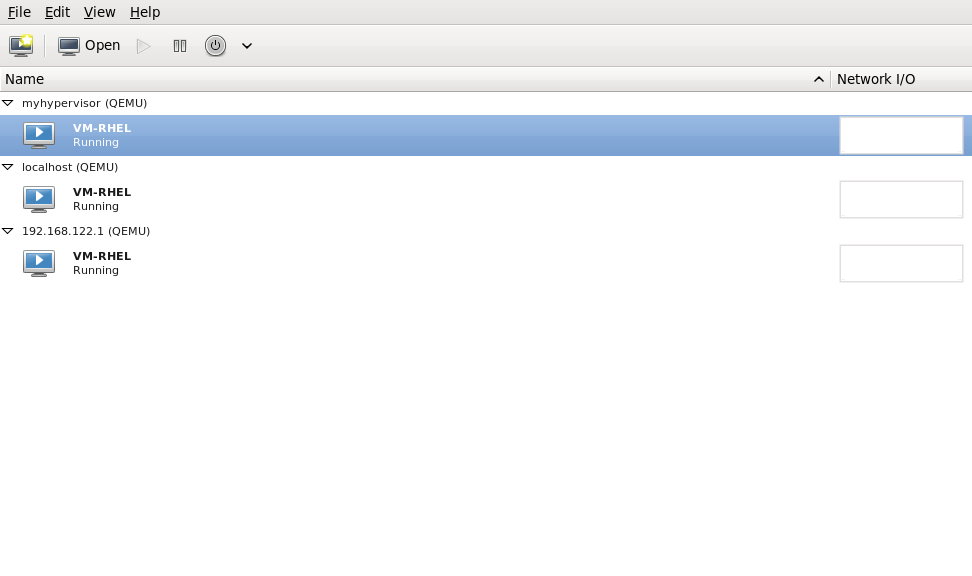

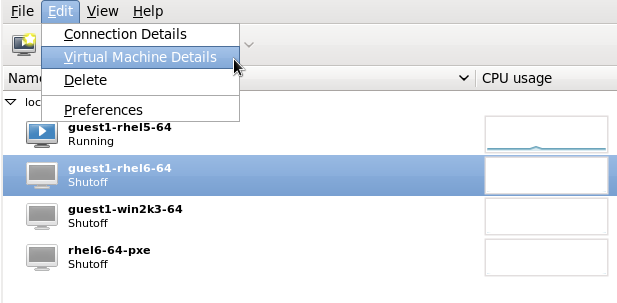

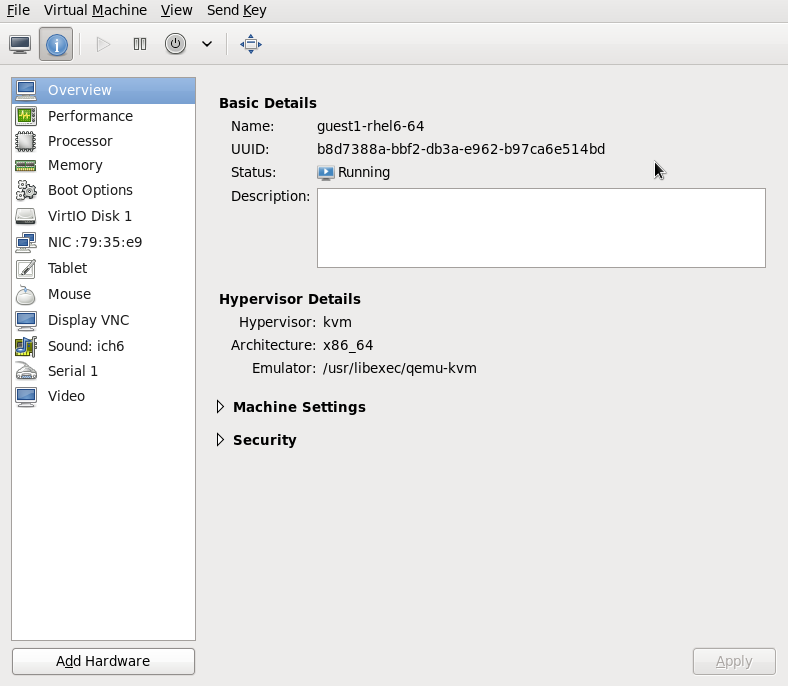

virt-manager を開きます。メインメニューバーから Applications → System Tools → Virtual Machine Manager を選択して、virt-manager を起動します。図4.1 virt-Manager のメインメニュー

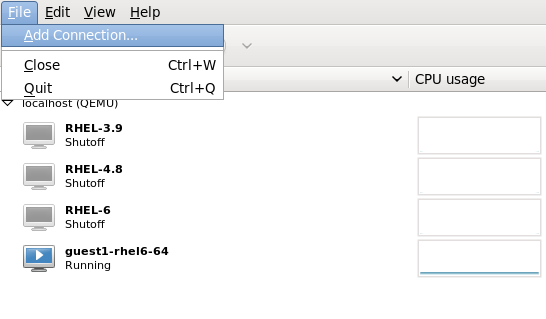

ターゲットホストの物理マシンへの接続

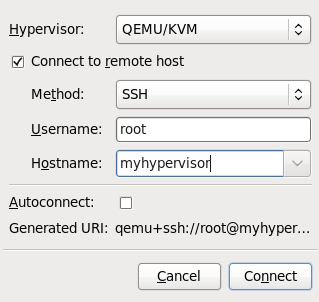

File メニューをクリックしてターゲットホストの物理マシンに接続し、Add Connection をクリックします。図4.2 Add Connection ウィンドウの表示

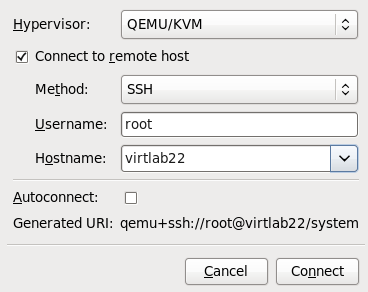

接続の追加

Add Connection ウィンドウが表示されます。図4.3 ターゲットホストの物理マシンへの接続の追加

以下の詳細を入力します。

以下の詳細を入力します。- Hypervisor: QEMU/KVM を選択します。

- Method: 接続方法を選択します。

- Username: リモートホストの物理マシンのユーザー名を入力します。

- Hostname: リモートホストの物理マシンのホスト名を入力します。

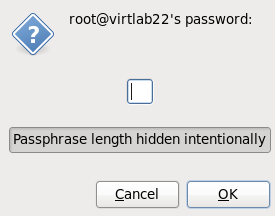

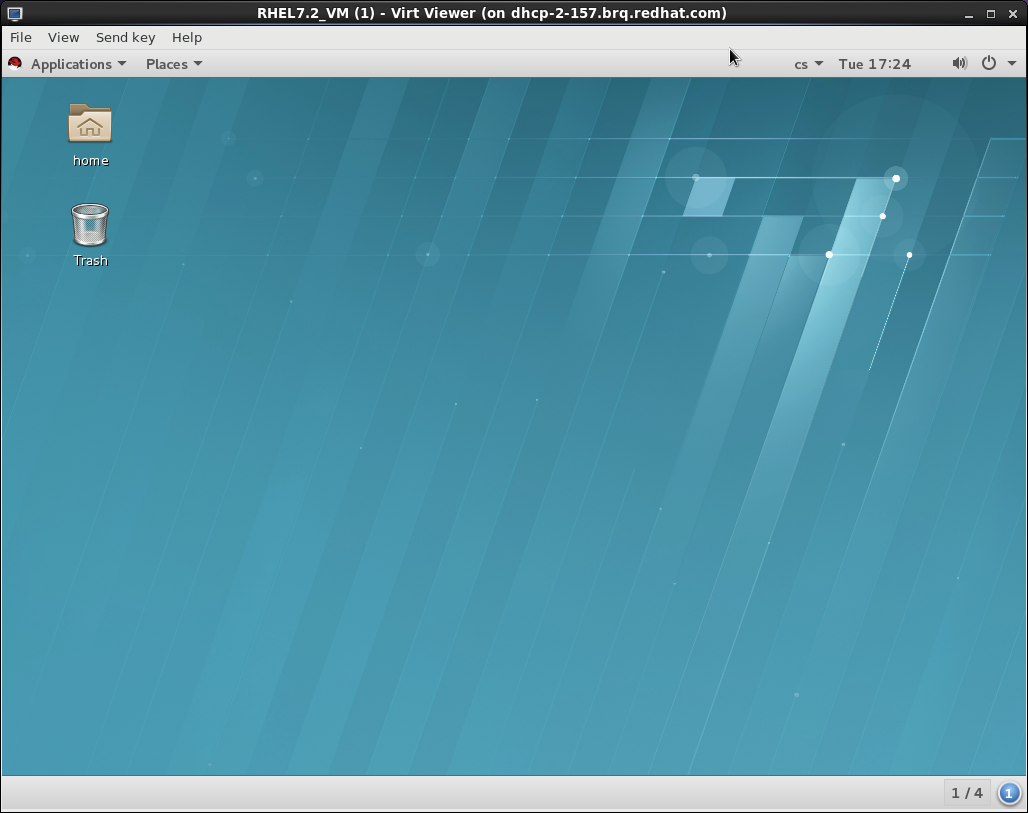

Connect ボタンをクリックします。この例では SSH 接続を使用しているため、次の手順で指定するユーザーのパスワードを入力する必要があります。図4.4 パスワードを入力

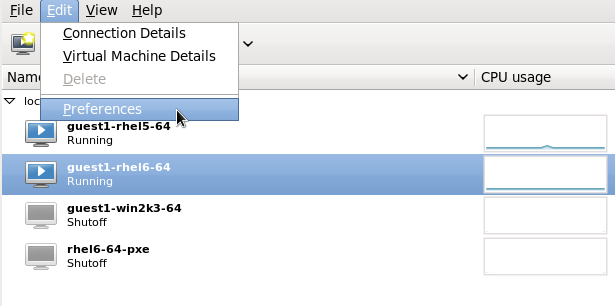

ゲスト仮想マシンの移行

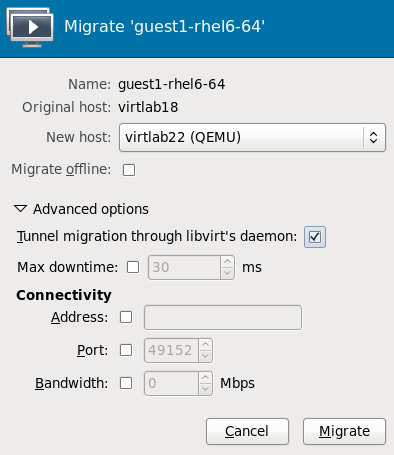

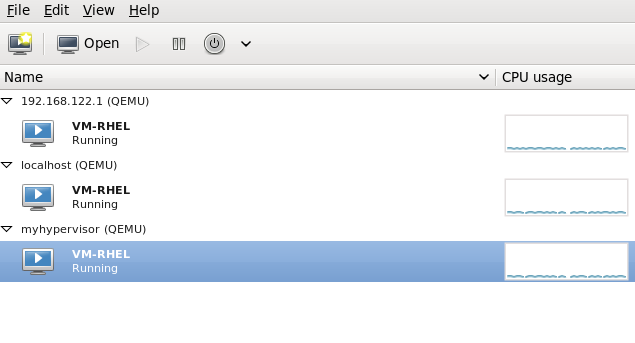

ソースホスト物理マシン内のゲストのリストを開き (ホスト名の左側にある小さな三角形をクリック)、移行するゲスト (この例では guest1-rhel6-64) を右クリックして、Migrate をクリックします。図4.5 移行するゲストの選択

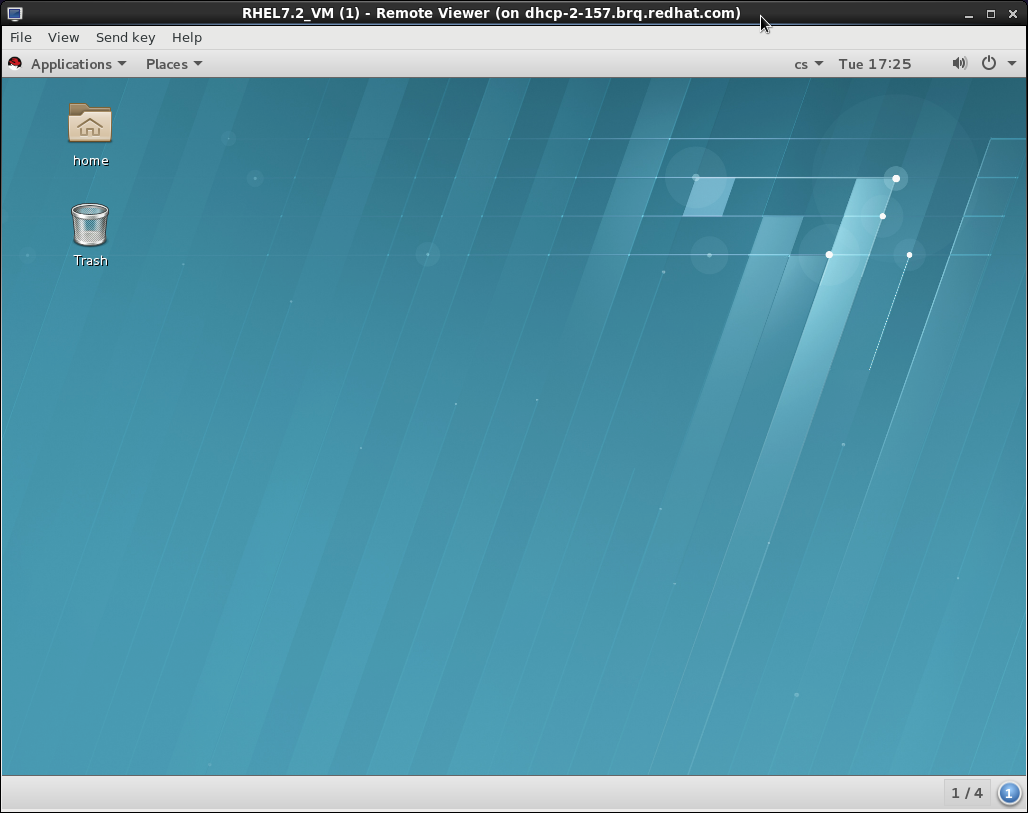

New Host フィールドで、ドロップダウンリストを使用して、ゲスト仮想マシンの移行先となるホスト物理マシンを選択し、Migrate をクリックします。

New Host フィールドで、ドロップダウンリストを使用して、ゲスト仮想マシンの移行先となるホスト物理マシンを選択し、Migrate をクリックします。図4.6 移行先ホストの物理マシンの選択と、移行プロセスの開始

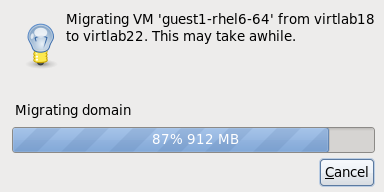

進捗ウィンドウが表示されます。

進捗ウィンドウが表示されます。図4.7 進捗ウィンドウ

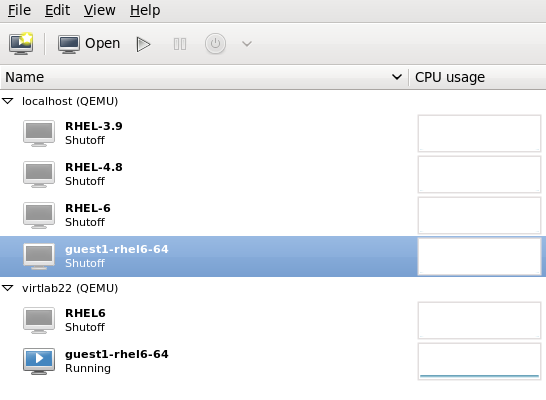

virt-manager は、移行先ホストで実行されている、新しく移行されたゲスト仮想マシンを表示するようになりました。これで、ソースホストの物理マシンで実行されていたゲスト仮想マシンがシャットオフ状態で一覧表示されます。

virt-manager は、移行先ホストで実行されている、新しく移行されたゲスト仮想マシンを表示するようになりました。これで、ソースホストの物理マシンで実行されていたゲスト仮想マシンがシャットオフ状態で一覧表示されます。図4.8 移行先ホストの物理マシンで実行している移行ゲスト仮想マシン

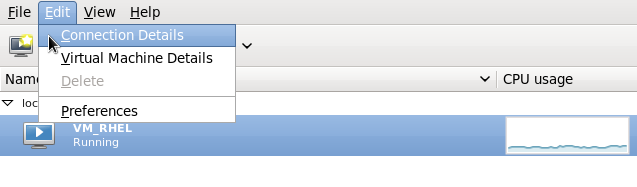

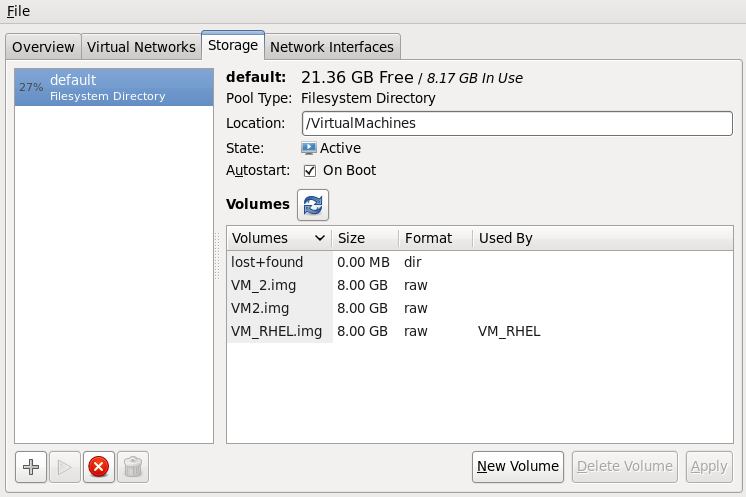

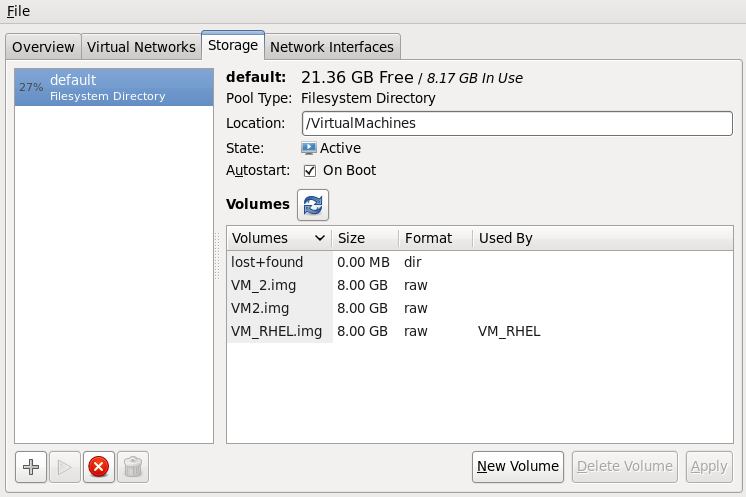

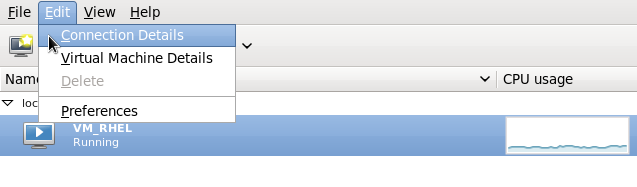

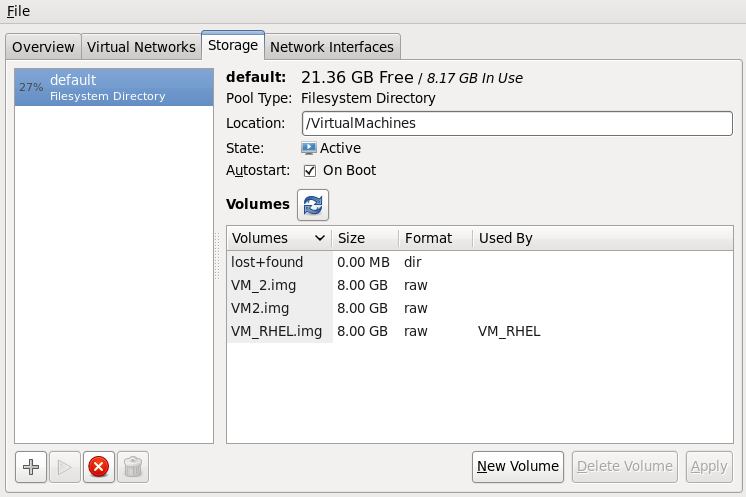

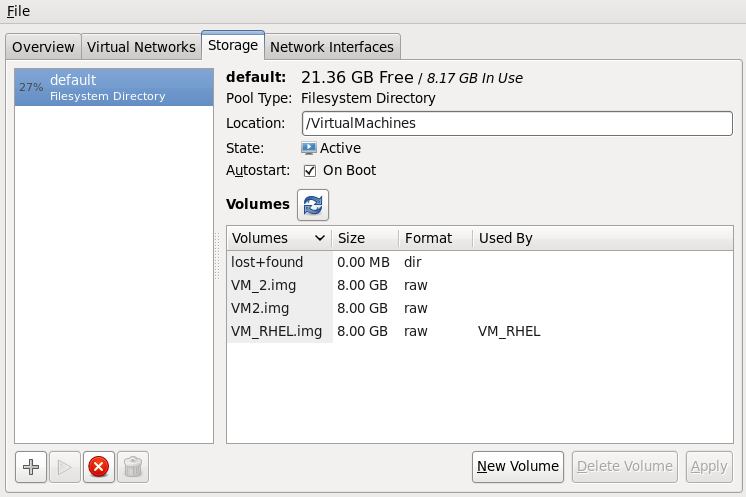

オプション: ホストの物理マシンのストレージの詳細を表示します。

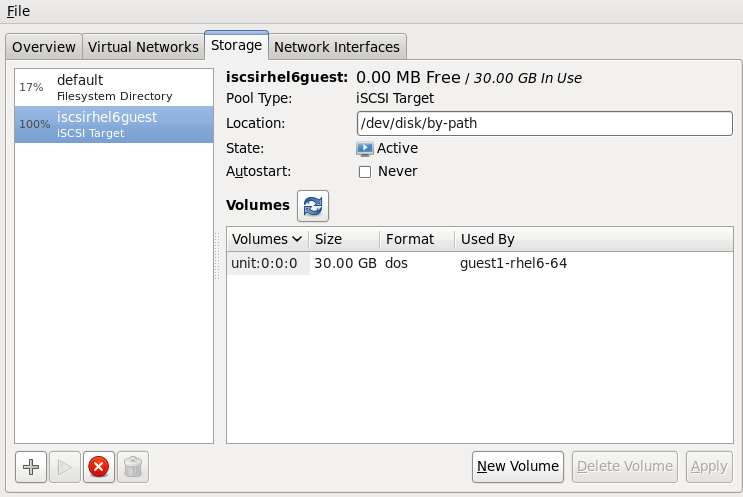

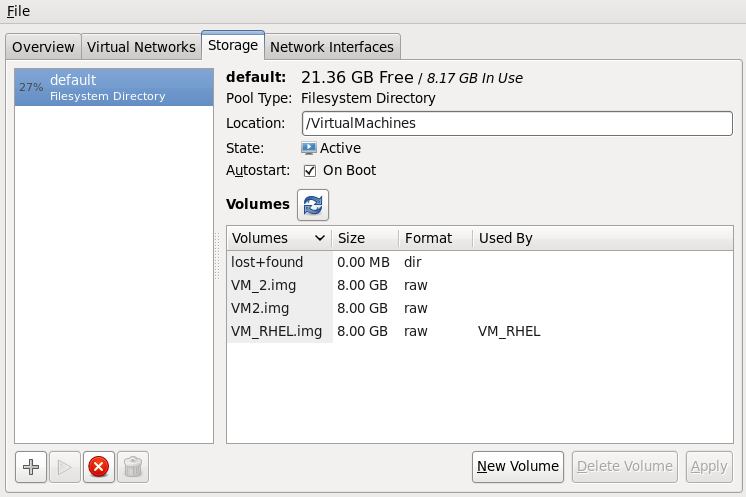

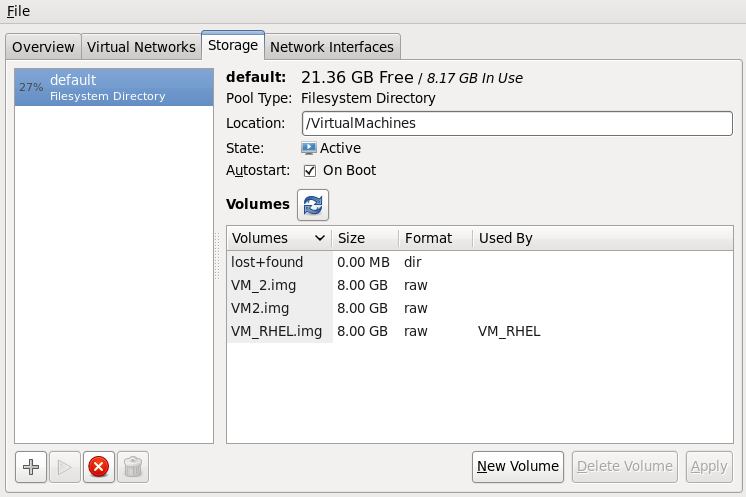

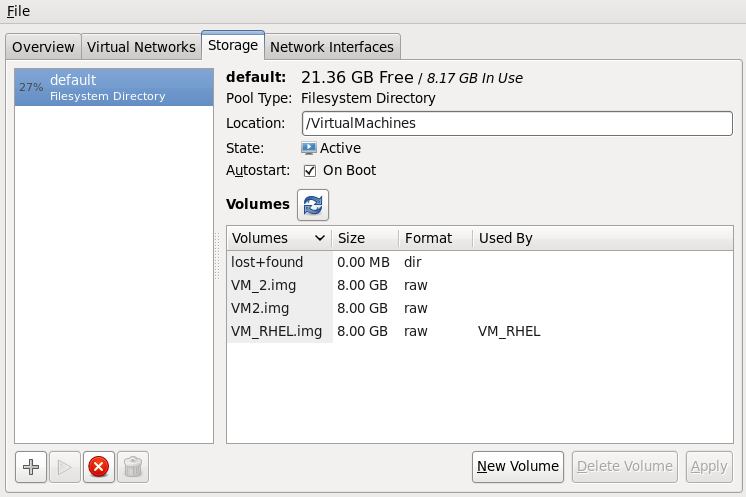

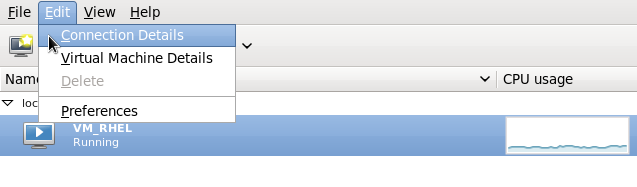

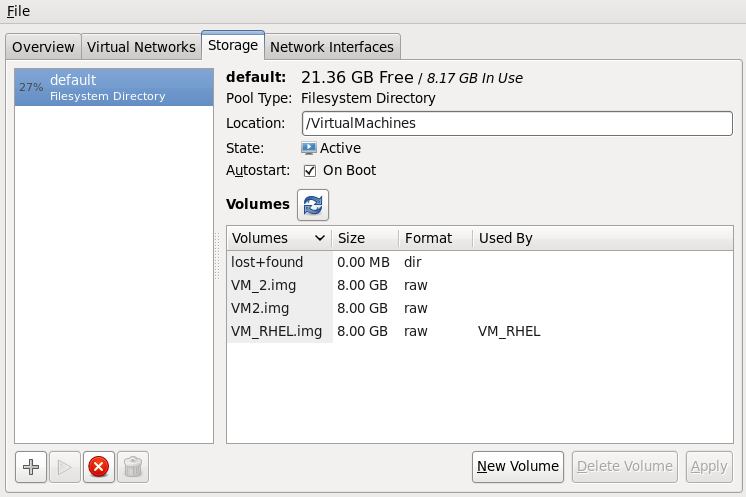

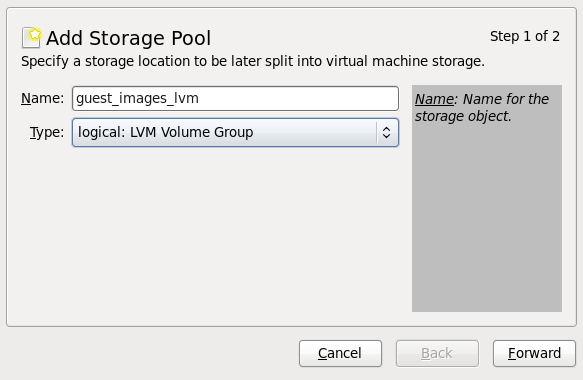

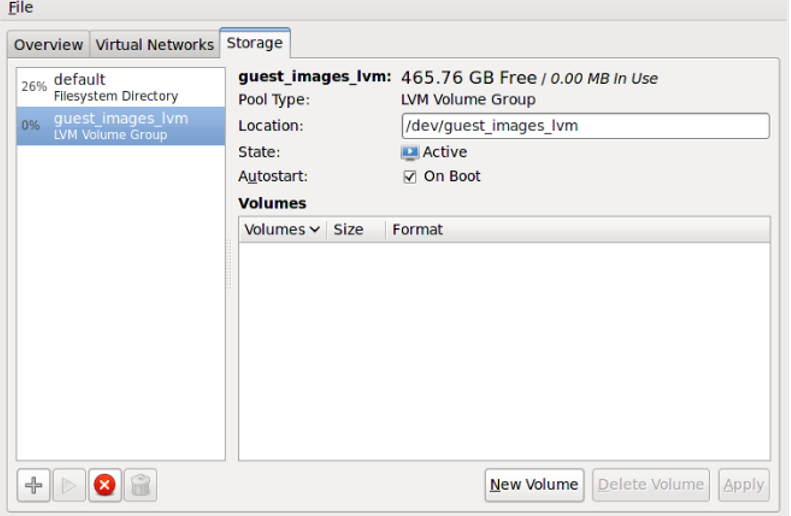

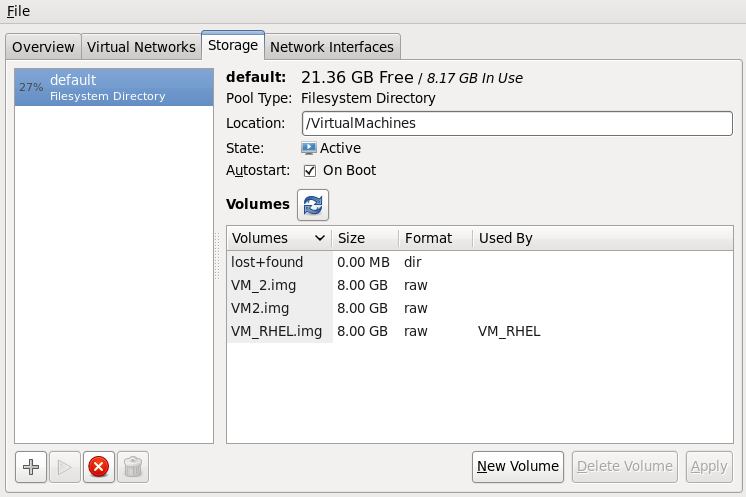

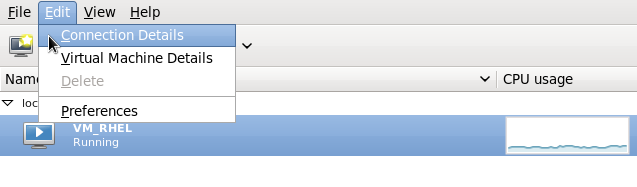

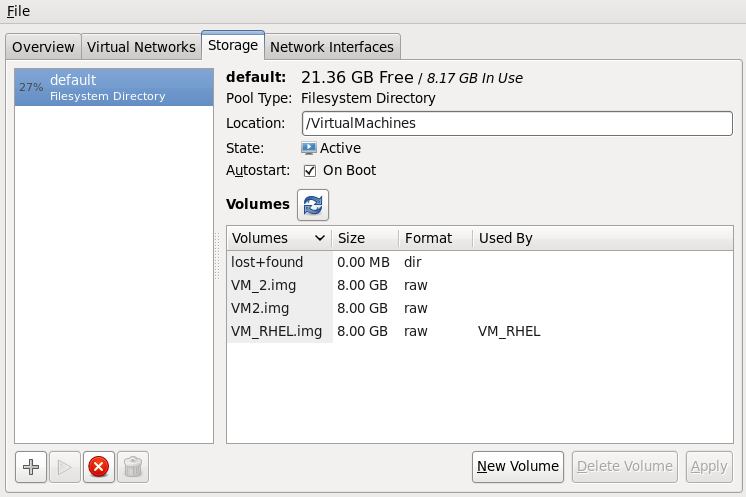

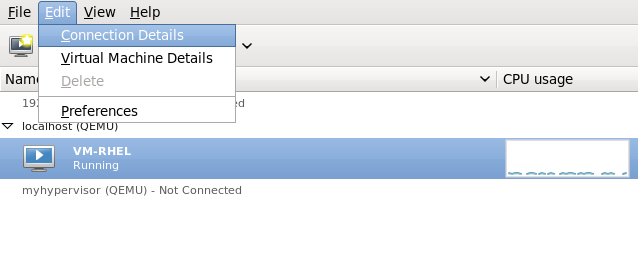

Edit メニューで Connection Details をクリックすると、Connection Details ウィンドウが表示されます。Storage タブをクリックします。移行先ホストの物理マシンの iSCSI ターゲットの詳細が表示されます。移行したゲスト仮想マシンがストレージを使用するものとして一覧表示されることに注意してください。図4.9 ストレージの詳細

このホストは、以下の XML 設定で定義されています。

このホストは、以下の XML 設定で定義されています。図4.10 宛先ホスト物理マシンの XML 設定

<pool type='iscsi'> <name>iscsirhel6guest</name> <source> <host name='virtlab22.example.com.'/> <device path='iqn.2001-05.com.iscsivendor:0-8a0906-fbab74a06-a700000017a4cc89-rhevh'/> </source> <target> <path>/dev/disk/by-path</path> </target> </pool> ...

第5章 ゲストのリモート管理

5.1. SSH を使用したリモート管理

- 仮想マシンを管理するには、リモートマシンへの root ログインアクセスが必要です。

- 初期接続の設定プロセスが遅くなる可能性があります。

- すべてのホストまたはゲストでユーザーのキーを取り消す標準または簡単な方法はありません。

- SSH は、リモートマシンの数が多いと適切にスケーリングされません。

- openssh

- openssh-askpass

- openssh-clients

- openssh-server

virt-manager 用にパスワードを使用しないまたはパスワードを使用したSSH アクセスの設定

以下の手順は、ゼロから開始しており、SSH キーが設定されていないことを前提としています。SSH 鍵を設定して別のシステムにコピーしている場合は、この手順をスキップできます。

オプション: ユーザーの変更

必要に応じてユーザーを変更します。この例では、ローカルの root ユーザーを使用して、その他のホストとローカルホストをリモートで管理します。$ su -SSH 鍵ペアの生成

virt-manager が使用されているマシンで公開鍵ペアを生成します。この例では、~/.ssh/ディレクトリーのデフォルトの鍵の場所を使用します。# ssh-keygen -t rsaリモートホストへの鍵のコピー

パスワードなしのリモートログイン、またはパスフレーズを使用したリモートログインでは、管理対象システムに SSH 鍵を配布する必要があります。ssh-copy-id コマンドを使用して、指定したシステムアドレス (この例ではroot@host2.example.com) の root ユーザーにキーをコピーします。# ssh-copy-id -i ~/.ssh/id_rsa.pub root@host2.example.com root@host2.example.com's password:次に、ssh root@host2.example.com コマンドを使用してマシンにログインし、.ssh/authorized_keysファイルをチェックインして予期しないキーが追加されていないことを確認します。必要に応じて、その他のシステムに対して繰り返します。オプション: パスフレーズを ssh-agent に追加します。

以下の手順では、既存の ssh-agent にパスフレーズを追加する方法について説明します。ssh-agent が実行されていない場合、実行に失敗します。エラーや競合を回避するには、SSH パラメーターが正しく設定されていることを確認してください。詳細は、『Red Hat Enterprise Linux 導入ガイド』 を参照してください。必要に応じて、SSH キーのパスフレーズを ssh-agent に追加します。ローカルホストで次のコマンドを使用して、パスフレーズ (存在する場合) を追加し、パスワードなしのログインを有効にします。# ssh-add ~/.ssh/id_rsaSSH キーがリモートシステムに追加されます。

libvirt デーモン (libvirtd)

libvirt デーモンは、仮想マシンを管理するインターフェイスを提供します。管理が必要なすべてのリモートホストに libvirtd デーモンをインストールして実行する必要があります。

$ ssh root@somehost # chkconfig libvirtd on # service libvirtd start

libvirtd と SSH を設定すると、仮想マシンにリモートでアクセスして管理できるようになります。この時点で、VNC でゲストにアクセスできるようになるはずです。

virt-manager を使用したリモートホストへのアクセス

リモートホストは、virt-manager GUI ツールで管理できます。SSH キーは、パスワードを使用しないログインを機能させるために、virt-manager を実行しているユーザーに属している必要があります。

- virt-manager を起動します。

- File ->Add Connection メニューを開きます。

図5.1 Add Connection メニュー

- ドロップダウンメニューを使用してハイパーバイザータイプを選択し、Connect to remote host チェックボックスをクリックして Connection Method (この場合は Remote tunnel over SSH) を開き、必要な User name と Hostname を入力して Connect をクリックします。

5.2. TLS および SSL でのリモート管理

手順5.1 TLS 管理用の認証局 (CA) 鍵の作成

- 始める前に、certtool ユーティリティーがインストールされていることを確認してください。そうでない場合は、以下を行います。

# yum install gnutls-utils - 次のコマンドを使用して、秘密鍵を生成します。

# certtool --generate-privkey > cakey.pem - キーが生成されたら、次のステップは、キーが自己署名できるように署名ファイルを作成することです。作成するには、署名の詳細が含まれるファイルを作成し、

ca.infoという名前を付けます。このファイルには、以下の内容を記述する必要があります。# vim ca.infocn = Name of your organization ca cert_signing_key

- 以下のコマンドを使用して自己署名キーを生成します。

# certtool --generate-self-signed --load-privkey cakey.pem --template ca.info --outfile cacert.pemファイルが生成されたら、rm コマンドを使用して ca.info ファイルを削除できます。生成プロセスの結果として生成されるファイルの名前はcacert.pemです。このファイルは公開鍵 (証明書) です。読み込んだcakey.pemは秘密鍵です。このファイルは共有スペースに保存しないでください。この鍵は秘密鍵を保持します。 /etc/pki/CA/cacert.pemディレクトリー内のすべてのクライアントとサーバーにcacert.pem認証局証明書ファイルをインストールして、CA によって発行された証明書が信頼できることを通知します。このファイルの内容を表示するには、次のコマンドを実行します。# certtool -i --infile cacert.pemこれは、CA の設定に必要なものです。クライアントとサーバーの証明書を発行するために必要となるため、CA の秘密鍵を安全に保持します。

手順5.2 サーバー証明書の発行

qemu://mycommonname/system を使用してサーバーに接続するため、CN フィールドは同一である必要があります (mycommoname)。

- サーバーの秘密鍵を作成します。

# certtool --generate-privkey > serverkey.pem - 最初に

server.infoというテンプレートファイルを作成して、CA の秘密鍵の署名を生成します。CN がサーバーのホスト名と同じに設定されていることを確認します。organization = Name of your organization cn = mycommonname tls_www_server encryption_key signing_key

- 次のコマンドを使用して証明書を作成します。

# certtool --generate-certificate --load-privkey serverkey.pem --load-ca-certificate cacert.pem --load-ca-privkey cakey.pem \ --template server.info --outfile servercert.pem - これにより、2 つのファイルが生成されます。

- serverkey.pem - サーバーの秘密鍵

- servercert.pem - サーバーの公開鍵

秘密鍵の場所は、秘密にしておきます。ファイルの内容を表示するには、以下のコマンドを実行します。# certtool -i --inifile servercert.pemこのファイルを開く場合、CN=パラメーターは先に設定した CN と同じでなければなりません。(例:mycommonname) - 次の場所にある 2 つのファイルをインストールします。

serverkey.pem- サーバーの秘密鍵。このファイルは、/etc/pki/libvirt/private/serverkey.pemに置きます。servercert.pem- サーバーの証明書。サーバーの/etc/pki/libvirt/servercert.pemにインストールします。

手順5.3 クライアント証明書の発行

- すべてのクライアント (つまり、virt-manager などの libvirt にリンクされているプログラム) について、X.509 識別名 (DN) が適切な名前に設定された証明書を発行する必要があります。これは、企業レベルで決定する必要があります。たとえば、以下の情報が使用されます。

C=USA,ST=North Carolina,L=Raleigh,O=Red Hat,CN=name_of_client

このプロセスは、以下の例外を除き、手順5.2「サーバー証明書の発行」 と非常に似ています。 - 以下のコマンドを使用して秘密鍵を作成します。

# certtool --generate-privkey > clientkey.pem - 最初に

client.infoという名前のテンプレートファイルを作成して、CA の秘密鍵の署名を生成します。ファイルには以下の内容が含まれている必要があります (フィールドは、お住まいの地域/場所に合わせてカスタマイズする必要があります)。country = USA state = North Carolina locality = Raleigh organization = Red Hat cn = client1 tls_www_client encryption_key signing_key

- 次のコマンドを使用して、証明書に署名します。

# certtool --generate-certificate --load-privkey clientkey.pem --load-ca-certificate cacert.pem \ --load-ca-privkey cakey.pem --template client.info --outfile clientcert.pem - クライアントマシンに証明書をインストールします。

# cp clientkey.pem /etc/pki/libvirt/private/clientkey.pem # cp clientcert.pem /etc/pki/libvirt/clientcert.pem

5.3. トランスポートモード

Transport Layer Security (TLS)

Transport Layer Security TLS 1.0 (SSL 3.1) が認証され、暗号化された TCP/IP ソケット。通常はパブリックポート番号をリッスンします。これを使用するには、クライアント証明書とサーバー証明書を生成する必要があります。標準のポートは 16514 です。

UNIX ソケット

UNIX ドメインソケットは、ローカルマシンでのみアクセスできます。ソケットは暗号化されず、UNIX の権限または SELinux を使用して認証を行います。通常のソケット名は /var/run/libvirt/libvirt-sock および /var/run/libvirt/libvirt-sock-ro です (読み取り専用接続の場合)。

SSH

SSH (Secure Shell Protocol) 接続で転送されます。Netcat が必要です (ncパッケージ) がインストールされています。libvirt デーモン (libvirtd) は、リモートマシンで実行している必要があります。SSH アクセスには、ポート 22 を開いておく必要があります。ある種の SSH キー管理 (たとえば、ssh-agentユーティリティー) を使用する必要があります。そうしないと、パスワードの入力を求められます。

ext

ext パラメーターは、libvirt のスコープ外の方法でリモートマシンに接続できる外部プログラムに使用されます。このパラメーターはサポートされていません。

TCP

暗号化されていない TCP/IP ソケット。実稼働環境での使用は推奨されていないため、これは通常無効になっていますが、管理者はこれをテストしたり、信頼できるネットワークで使用したりできます。デフォルトのポートは 16509 です。

リモート URI

URI (Uniform Resource Identifier) は、virsh および libvirt がリモートホストに接続するために使用します。URI は、virsh コマンドの --connect パラメーターとともに使用して、リモートホストで単一コマンドまたは移行を実行することもできます。リモート URI は、通常のローカル URI を取得し、ホスト名またはトランスポート名を追加することで形成されます。特別な場合として、remote の URI スキームを使用すると、リモートの libvirtd サーバーで、最適なハイパーバイザードライバーをプローブするように指示されます。これは、ローカル接続の NULL URI を渡すことに相当します。

driver[+transport]://[username@][hostname][:port]/path[?extraparameters]

- qemu://hostname/

- xen://hostname/

- xen+ssh://hostname/

リモート管理パラメーターの例

- SSH トランスポートと SSH ユーザー名

virtuserを使用して、host2という名前のリモート KVM ホストに接続します。それぞれの connect コマンドは connect [<name>] [--readonly] です。ここで、<name> はここで説明する有効な URI です。virsh connect コマンドの詳細については、「connect」 を参照してください。qemu+ssh://virtuser@hot2/ - TLS を使用して、

host2という名前のホスト上のリモートの KVM ハイパーバイザーに接続します。qemu://host2/

テスト例

- 標準以外の UNIX ソケットを使用して、ローカルの KVM ハイパーバイザーに接続します。この場合は、UNIX ソケットの完全パスが明示的に指定されています。

qemu+unix:///system?socket=/opt/libvirt/run/libvirt/libvirt-sock - 暗号化されていない TCP/IP 接続を使用して、ポート 5000 の IP アドレス 10.1.1.10 のサーバーに libvirt デーモンを接続します。これは、デフォルト設定でテストドライバーを使用します。

test+tcp://10.1.1.10:5000/default

追加の URI パラメーター

リモートの URI には、追加のパラメーターを追加できます。以下の表 表5.1「追加の URI パラメーター」 では、認識されるパラメーターを説明します。その他のパラメーターはすべて無視されます。パラメーター値は URI エスケープする必要があります (つまり、パラメーターおよび特殊文字が URI 形式に変換される前に疑問符 (?) が追加されることを意味します)。

表5.1 追加の URI パラメーター

| 名前 | トランスポートモード | 説明 | 使用例 |

|---|---|---|---|

| name | すべてのモード | リモートの virConnectOpen 関数に渡される名前。名前は、通常、リモートの URI から transport、hostname、port number、username、および追加のパラメーターを削除して生成されますが、非常に複雑なケースでは、名前を明示的に指定することをお勧めします。 | name=qemu:///system |

| command | ssh と ext | 外部コマンド。ext トランスポートの場合はこれが必要です。ssh の場合、デフォルトは ssh です。コマンド用に PATH が検索されます。 | command=/opt/openssh/bin/ssh |

| socket | unix と ssh | UNIX ドメインソケットへのパスで、デフォルトを上書きします。ssh トランスポートの場合は、これがリモートの netcat コマンド (netcat を参照) に渡されます。 | socket=/opt/libvirt/run/libvirt/libvirt-sock |

| netcat | ssh |

netcat コマンドを使用して、リモートシステムに接続できます。デフォルトの netcat パラメーターは nc コマンドを使用します。SSH トランスポートの場合、libvirt は以下の形式を使用して SSH コマンドを構築します。

command -p port [-l username] hostname

netcat -U ソケット

port、username、および hostname パラメーターは、リモート URI の一部として指定できます。command、netcat、および socket は、他の追加パラメーターから取得されます。

| netcat=/opt/netcat/bin/nc |

| no_verify | tls | ゼロ以外の値に設定すると、サーバーの証明書のクライアントチェックが無効になります。クライアントの証明書または IP アドレスのサーバーチェックを無効にするには、libvirtd 設定を変更する必要があります。 | no_verify=1 |

| no_tty | ssh | 0 以外の値に設定すると、リモートマシンに自動的にログインできない場合に ssh がパスワードを要求できなくなります。ターミナル へのアクセスがない場合は、これを使用します。 | no_tty=1 |

第6章 KVM でのオーバーコミット

6.1. メモリーのオーバーコミット

6.2. 仮想 CPU のオーバーコミット

第7章 KSM

qemu-kvm プロセスからメモリーのみが継承されます。ゲスト仮想マシンが実行されると、ゲストが同じオペレーティングシステムまたはアプリケーションを実行しているときに、ゲスト仮想マシンのオペレーティングシステムイメージのコンテンツを共有できます。

/sys/kernel/mm/ksm/merge_across_nodes を 0 に変更して、NUMA ノード間でページがマージされないようにします。カーネルメモリーが計算した統計情報は、ノード間での大量のマージ後にはそれぞれの間で相反する場合があります。そのため、KSM デーモンが大量のメモリーをマージすると、numad が混乱する可能性があります。システムに未使用のメモリーが大量にあると、KSM デーモンをオフにして無効にすることでパフォーマンスが高まる場合があります。NUMA の詳細は、『Red Hat Enterprise Linux パフォーマンスチューニングガイド』 を参照してください。

ksmサービスは、KSM カーネルスレッドを開始および停止します。ksmtunedサービスはksmを制御し、調整し、同じページのマージを動的に管理します。ksmtunedサービスはksmを開始し、メモリー共有が必要ない場合はksmサービスを停止します。ksmtunedサービスは、retune新しいゲストが作成または破棄されたときに実行するパラメーター。

KSM サービス

ksm サービスは qemu-kvm パッケージに含まれています。KSM は、Red Hat Enterprise Linux 6 ではデフォルトでオフになっています。ただし、Red Hat Enterprise Linux 6 を KVM ホスト物理マシンとして使用する場合は、ksm/ksmtuned サービスによってオンにされる可能性があります。

ksm サービスが開始されていない場合、KSM は 2000 ページのみを共有します。このデフォルトは低く、メモリー節約の利点は限られています。

ksm サービスが開始されると、KSM はホスト物理マシンシステムのメインメモリーの最大半分を共有します。ksm サービスを開始して、KSM がより多くのメモリーを共有できるようにしてください。

# service ksm start Starting ksm: [ OK ]

ksm サービスは、デフォルトの起動シーケンスに追加できます。chkconfig コマンドを使用して、ksm サービスを永続化します。

# chkconfig ksm on

KSM チューニングサービス

ksmtuned サービスにはオプションがありません。ksmtuned サービスは、ksm をループして調整します。さらに、ゲスト仮想マシンが作成または破棄されると、ksmtuned サービスに libvirt から通知されます。

# service ksmtuned start Starting ksmtuned: [ OK ]

ksmtuned サービスは、retune パラメーターを使用して調整できます。retune パラメーターは、チューニング機能を手動で実行するように ksmtuned に指示します。

thres: アクティベーションキーのしきい値 (kbytes)KSM サイクルは、全thresプロセス RSZ の合計にシステムメモリーの合計にqemu-kvm値が追加されるとトリガーされます。このパラメーターは、KSM_THRES_COEFで定義されたパーセンテージの kbytes と同じです。

/etc/ksmtuned.conf ファイルは、ksmtuned サービスの設定ファイルです。以下のファイル出力は、デフォルトの ksmtuned.conf ファイルです。

# Configuration file for ksmtuned. # How long ksmtuned should sleep between tuning adjustments # KSM_MONITOR_INTERVAL=60 # Millisecond sleep between ksm scans for 16Gb server. # Smaller servers sleep more, bigger sleep less. # KSM_SLEEP_MSEC=10 # KSM_NPAGES_BOOST is added to thenpagesvalue, whenfree memoryis less thanthres. # KSM_NPAGES_BOOST=300 # KSM_NPAGES_DECAY Value given is subtracted to thenpagesvalue, whenfree memoryis greater thanthres. # KSM_NPAGES_DECAY=-50 # KSM_NPAGES_MIN is the lower limit for thenpagesvalue. # KSM_NPAGES_MIN=64 # KSM_NAGES_MAX is the upper limit for thenpagesvalue. # KSM_NPAGES_MAX=1250 # KSM_TRES_COEF - is the RAM percentage to be calculated in parameterthres. # KSM_THRES_COEF=20 # KSM_THRES_CONST - If this is a low memory system, and thethresvalue is less thanKSM_THRES_CONST, then resetthresvalue toKSM_THRES_CONSTvalue. # KSM_THRES_CONST=2048 # uncomment the following to enable ksmtuned debug information # LOGFILE=/var/log/ksmtuned # DEBUG=1

KSM 変数とモニターリング

KSM は、監視データを /sys/kernel/mm/ksm/ ディレクトリーに保存します。このディレクトリー内のファイルは、カーネルによって更新される、KSM の使用状況と統計の正確な記録です。

/etc/ksmtuned.conf ファイルの設定可能な変数でもあります。

/sys/kernel/mm/ksm/ ファイル

- full_scans

- フルスキャンが実行されます。

- pages_shared

- 共有されたページの総数。

- pages_sharing

- 現在共有されているページ。

- pages_to_scan

- スキャンされていないページ。

- pages_unshared

- 共有されなくなったページ。

- pages_volatile

- 揮発性ページの数。

- run

- KSM プロセスが実行されているかどうか。

- sleep_millisecs

- スリープのミリ秒。

DEBUG=1 行が /etc/ksmtuned.conf ファイルに追加された場合、KSM チューニングアクティビティーは /var/log/ksmtuned ログファイルに保存されます。ログファイルの場所は、LOGFILE パラメーターを使用して変更することができます。ログファイルの場所を変更することはお勧めできません。SELinux 設定の特別な設定が必要になる場合があります。

KSM の非アクティブ化

KSM にはパフォーマンスのオーバーヘッドがあり、特定の環境またはホストの物理マシンシステムには大きすぎる可能性があります。

ksmtuned および ksm サービスを停止することで非アクティブ化できます。サービスを停止すると KSM が非アクティブになりますが、再起動後も持続しません。

# service ksmtuned stop Stopping ksmtuned: [ OK ] # service ksm stop Stopping ksm: [ OK ]

# chkconfig ksm off # chkconfig ksmtuned off

第8章 高度なゲスト仮想マシン管理

8.1. コントロールグループ (cgroup)

8.2. Huge Page のサポート

はじめに

x86 CPU は通常、4kB ページのメモリーに対応しますが、Huge Page と呼ばれる大容量のページを使用できます。KVM ゲストは、Transaction Lookaside Buffer (TLB) に対する CPU キャッシュヒットを増やすことでパフォーマンスを向上させるために、Huge Page メモリーサポートを使用してデプロイできます。特に大容量メモリーとメモリーを大量に消費するワークロードなど、Huge Page によってパフォーマンスが大幅に向上する可能性があります。Red Hat Enterprise Linux 6 は、Huge Page を使用してページサイズを大きくすることにより、大量のメモリーをより効果的に管理できます。

Transparent Huge Pages

Transparent Huge Page (THP) は、アプリケーションに必要な TLB エントリーを減らすカーネル機能です。また、すべての空きメモリーをキャッシュとして使用するようにすることで、パフォーマンスが向上します。

qemu.conf ファイルに特別な設定は必要ありません。/sys/kernel/mm/redhat_transparent_hugepage/enabled が always に設定されている場合、Huge Page はデフォルトで使用されます。

hugetlbfs 機能の使用は妨げられません。ただし、hugetlbfs が使用されていない場合、KVM は通常の 4kB ページサイズの代わりに透過的な巨大ページを使用します。

8.3. Hyper-V ハイパーバイザーでのゲスト仮想マシンとしての Red Hat Enterprise Linux の実行

- VMBUS プロトコルのアップグレード - VMBUS プロトコルが Windows 8 レベルにアップグレードされました。この作業の一環として、ゲストで利用可能な全仮想 CPU で VMBUS 割り込みを処理できるようになりました。さらに、Red Hat Enterprise Linux ゲスト仮想マシンと Windows ホストの物理マシン間のシグナルプロトコルが最適化されています。

- 合成フレームバッファードライバー - Red Hat Enterprise Linux デスクトップユーザー向けのグラフィックパフォーマンスと優れた解決策を提供します。

- ライブ仮想マシンのバックアップサポート: ライブの Red Hat Enterprise Linux ゲスト仮想マシンの中断のないバックアップサポートをプロビジョニングします。

- 固定サイズの Linux VHD 動的拡張 - ライブマウントされた固定サイズ Red Hat Enterprise Linux VHD の拡張を可能にします。

8.4. ゲスト仮想マシンのメモリー割り当て

- バイトの場合は

bまたはbytesになります。 - キロバイトの場合は、

KBになります (10 3 または 1,000 バイトのブロック) - キビバイトの場合は

kまたはKiB(2 10 または 1024 バイトのブロック) MBメガバイトの場合 (10 6 または 1,000,000 バイトのブロック)- メビバイトの場合は

MまたはMiB(220 または 1,048,576 バイトのブロック) GB(ギガバイト) (109 または 1,000,000,000 バイトのブロック)- ギビバイトの場合は

GまたはGiB(30 または 1,073,741,824 バイトのブロック) - エクサバイトの場合は

TB(1012 または 1,000,000,000,000 バイト のブロック) - テビバイトの場合は

TまたはTiB(2 40 または 1,099,511,627,776 のブロック)

memory unit により決定されます。デフォルトは、測定単位としての KiB (キビバイト) になります。この値は、210 または 1024 バイトのブロックで乗算されます。

dumpCore を使用して、ゲスト仮想マシンのメモリーを、生成されるコアダンプ (dumpCore='on') に含めるか (dumpCore='off') 含まないかを制御できます。デフォルト設定はonしたがって、パラメーターがに設定されていない場合off、ゲスト仮想マシンのメモリーはコアダンプファイルに含まれます。

currentMemory 属性は、ゲスト仮想マシンの実際のメモリー割り当てを決定します。この値は最大割り当てよりも低くなり、ゲスト仮想マシンのメモリーを即座にバルーンアップすることができます。これを省略すると、デフォルトでは memory 要素と同じ値に設定されます。unit 属性の動作は、メモリーと同じです。

<domain> <memory unit='KiB' dumpCore='off'>524288</memory> <!-- changes the memory unit to KiB and does not allow the guest virtual machine's memory to be included in the generated coredump file --> <currentMemory unit='KiB'>524288</currentMemory> <!-- makes the current memory unit 524288 KiB --> ... </domain>

8.5. ゲスト仮想マシンの自動起動

TestServer を設定して、ホストの物理マシンのブート時に自動的に起動します。

# virsh autostart TestServer

Domain TestServer marked as autostarted

--disable パラメーターを使用します。

# virsh autostart --disable TestServer

Domain TestServer unmarked as autostarted

8.6. ゲスト仮想マシンの SMART ディスク監視の無効化

# service smartd stop # chkconfig --del smartd

8.7. VNC サーバーの設定

~/.vnc/xstartup ファイルを作成してから編集し、vncserver が起動するたびに GNOME セッションを開始します。vncserver スクリプトの初回実行時に、VNC セッションに使用するパスワードの入力が求められます。vnc サーバーファイルの詳細は、『Red Hat Enterprise Linux インストールガイド』 を参照してください。

8.8. 新しい一意の MAC アドレスの生成

macgen.py として保存します。これで、そのディレクトリーから ./macgen.py を使用してスクリプトを実行でき、新しい MAC アドレスが生成されます。出力の例を以下に示します。

$ ./macgen.py 00:16:3e:20:b0:11

#!/usr/bin/python # macgen.py script to generate a MAC address for guest virtual machines # import random # def randomMAC(): mac = [ 0x00, 0x16, 0x3e, random.randint(0x00, 0x7f), random.randint(0x00, 0xff), random.randint(0x00, 0xff) ] return ':'.join(map(lambda x: "%02x" % x, mac)) # print randomMAC()

8.8.1. ゲスト仮想マシン用に新しい MAC を生成する別の方法

# echo 'import virtinst.util ; print\ virtinst.util.uuidToString(virtinst.util.randomUUID())' | python # echo 'import virtinst.util ; print virtinst.util.randomMAC()' | python

#!/usr/bin/env python # -*- mode: python; -*- print "" print "New UUID:" import virtinst.util ; print virtinst.util.uuidToString(virtinst.util.randomUUID()) print "New MAC:" import virtinst.util ; print virtinst.util.randomMAC() print ""

8.9. ゲスト仮想マシンの応答時間の改善

- 深刻なオーバーコミットされたメモリー。

- プロセッサーの使用率が高いオーバーコミットメモリー

- その他の (qemu-kvm プロセスではない) は、ホストの物理マシンのプロセスがビジー状態または停止している。

8.10. libvirt での仮想マシンタイマー管理

<clock> 要素は、ゲスト仮想マシンのクロックをホスト物理マシンのクロックと同期させる方法を決定するために使用されます。clock 要素には以下の属性があります。

offsetは、ゲスト仮想マシンのクロックがホストの物理マシンのクロックからどのようにオフセットされるかを決定します。offset 属性には、以下の値を使用できます。表8.1 offset 属性値

値 説明 utc ゲスト仮想マシンのクロックは、起動時に UTC に同期されます。 localtime ゲスト仮想マシンのクロックは、起動時にホストの物理マシンの設定済みタイムゾーンに同期されます (存在する場合)。 timezone ゲスト仮想マシンのクロックは、 timezone属性で指定された特定のタイムゾーンに同期されます。variable ゲスト仮想マシンクロックは UTC の任意のオフセットに同期されます。UTC との相対的なデルタは、 adjustment属性を使用して秒単位で指定します。ゲスト仮想マシンは、時間の経過とともにリアルタイムクロック (RTC) を自由に調整でき、次の再起動後にそれが受け入れられることを期待しています。これは、utcモードとは対照的に、リブートごとに RTC の調整が失われます。注記値 utc は、デフォルトで仮想マシンのクロックオフセットとして設定されます。ただし、ゲスト仮想マシンのクロックを localtime の値で実行している場合は、ゲスト仮想マシンのクロックをホスト物理マシンのクロックと同期させるため、クロックオフセットを変更して別の値にする必要があります。timezone属性は、ゲスト仮想マシンクロックに使用されるタイムゾーンを決定します。adjustment属性は、ゲスト仮想マシンのクロック同期にデルタを提供します。秒単位で、UTC との相対パスになります。

例8.1 常に UTC に同期する

<clock offset="utc" />

例8.2 常にホストの物理マシンのタイムゾーンに同期する

<clock offset="localtime" />

例8.3 任意のタイムゾーンへの同期

<clock offset="timezone" timezone="Europe/Paris" />

例8.4 UTC + 任意のオフセットに同期する

<clock offset="variable" adjustment="123456" />

8.10.1. クロックのタイマー子要素

name のみが必要で、他のすべての属性は任意です。

name 属性は使用する時間ソースの型を決定し、以下のいずれかになります。

表8.2 名前属性値

| 値 | 説明 |

|---|---|

| pit | Programmable Interval Timer - 周期的な割り込みがあるタイマーです。 |

| rtc | Real Time Clock - 周期的な割り込みがある継続的に実行するタイマー。 |

| tsc | Time Stamp Counter: リセットしてからのティック数をカウント、割り込みなし。 |

| kvmclock | KVM クロック: KVM ゲスト仮想マシンの推奨されるクロックソース。KVM pvclock または kvm-clock を使用すると、ゲスト仮想マシンがホストの物理マシンのウォールクロックタイムを読み取ることができます。 |

8.10.2. track

track 属性はタイマーによって追跡されるものを指定します。rtc の名前の値にのみ有効です。

表8.3 属性値を追跡する

| 値 | 説明 |

|---|---|

| boot | 古い ホストの物理マシン オプションに対応します。これはサポート対象外の追跡オプションです。 |

| guest | RTC は常にゲスト仮想マシンの時間を追跡します。 |

| wall | RTC は常にホスト時間を追跡します。 |

8.10.3. tickpolicy

tickpolicy 属性は、ゲスト仮想マシンにティックを渡すために使用されるポリシーを割り当てます。以下の値を使用できます。

表8.4 tickpolicy 属性値

| 値 | 説明 |

|---|---|

| delay | 通常のレートで配信を継続します (ティックが遅れます)。 |

| catchup | キャッチアップするために、より高いレートで配信されます。 |

| merge | ティックが 1 つのティックにマージされます。 |

| discard | 不明なティックはすべて破棄されます。 |

8.10.4. 頻度、モード、および表示

frequency 属性は固定頻度を設定するために使用されます。Hz で測定されます。この属性は、name 要素に tsc の値がある場合にのみ関連します。他のすべてのタイマーは固定周波数 (pit、rtc) で動作します。

mode は、タイムソースがゲスト仮想マシンに公開される方法を決定します。この属性は、tsc の name 値にのみ関係します。その他のタイマーは常にエミュレートされます。コマンドは以下のようになります。<timer name='tsc' frequency='NNN' mode='auto|native|emulate|smpsafe'/>モードの定義は表に記載されます。

表8.5 モード属性値

| 値 | 説明 |

|---|---|

| auto | TSC が不安定である場合はネイティブで、ネイティブの TSC アクセスを許可します。 |

| native | 常にネイティブ TSC アクセスを許可します。 |

| エミュレート | 常に TSC をエミュレートします。 |

| smpsafe | 常に TSC およびインロック SMP をエミュレートします。 |

present は、ゲスト仮想マシンに表示されるデフォルトのタイマーセットを上書きするために使用されます。

表8.6 present 属性値

| 値 | 説明 |

|---|---|

| はい | このタイマーがゲスト仮想マシンに表示されるよう強制します。 |

| いいえ | このタイマーをゲスト仮想マシンに表示しないように強制します。 |

8.10.5. クロック同期の使用例

例8.5 RTC および PIT タイマーとローカルタイムに同期されるクロック

<clock offset="localtime"> <timer name="rtc" tickpolicy="catchup" track="guest virtual machine" /> <timer name="pit" tickpolicy="delay" /> </clock>

- ゲスト仮想マシンには 1 つの CPU のみを指定可能

- APIC タイマーを無効にする必要があります (noapictimer コマンドラインオプションを使用)

- ゲストで NoHZ モードを無効にする必要があります (nohz = off コマンドラインオプションを使用)

- ゲストでは高解像度タイマーモードを無効にする必要があります (highres = off コマンドラインオプションを使用)

- PIT クロックソースは、高解像度タイマーモードまたは NoHz モードと互換性がありません。

8.11. PMU を使用したゲスト仮想マシンのパフォーマンスの監視

# yum install perf.8.12. ゲスト仮想マシン電源管理

...

<pm>

<suspend-to-disk enabled='no'/>

<suspend-to-mem enabled='yes'/>

</pm>

...

pm S3 (ディスクへのサスペンド) および S4 (メモリーへのサスペンド) ACPI スリープ状態の BIOS サポートを有効 (はい) または無効 (いいえ) にします。何も指定しないと、ハイパーバイザーはデフォルト値のままになります。

第9章 ゲスト仮想マシンデバイスの設定

- Emulated devices は、実際のハードウェアを模倣する純粋な仮想デバイスであり、未変更のゲストオペレーティングシステムは標準のインボックスドライバーを使用して動作できるようにします。Red Hat Enterprise Linux 6 は、216 virtio デバイスまで対応します。

- VirtIO devices は、仮想マシンで最適に動作するように設計された仮想デバイスです。VirtIO デバイスはエミュレートされたデバイスと似ていますが、Linux 以外の仮想マシンには、デフォルトで必要となるドライバーは含まれません。Virtual Machine Manager (virt-manager) や Red Hat Virtualization Hypervisor などの仮想化管理ソフトウェアは、サポートされている Linux 以外のゲストオペレーティングシステム用にこれらのドライバーを自動的にインストールします。Red Hat Enterprise Linux 6 は、最大 700 の scsi ディスクに対応します。

- 割り当てられたデバイス は、仮想マシンに公開される物理デバイスです。このメソッドは passthrough としても知られています。デバイスの割り当てにより、仮想マシンはさまざまなタスクで PCI デバイスに排他的にアクセスできるようになり、PCI デバイスがゲストオペレーティングシステムに物理的に接続されているかのように見え、動作します。Red Hat Enterprise Linux 6 は、仮想マシンごとに割り当てられたデバイスを最大 32 個までサポートします。

/etc/security/limits.conf で設定され、/etc/libvirt/qemu.conf でオーバーライドできます)。他の制限要因には、仮想バスで利用可能なスロット数や、sysctl で設定されたオープンファイルのシステム全体の制限が含まれます。

allow_unsafe_interrupts vfio_iommu_type1 モジュールへのオプションを使用して引き続き PCI デバイスの割り当てを許可することを選択できます。これは、以下を含む /etc/modprobe.d に .conf ファイル (local.conf など) を追加することで、永続的に実行できます。

options vfio_iommu_type1 allow_unsafe_interrupts=1または sysfs エントリーを使用して動的に同じことを行います。

# echo 1 > /sys/module/vfio_iommu_type1/parameters/allow_unsafe_interrupts

9.1. PCI デバイス

手順9.1 PCI デバイス割り当てのための Intel システムの準備

Intel VT-d 仕様を有効にする

Intel VT-d 仕様では、物理デバイスを仮想マシンに直接割り当てるハードウェアサポートが提供されます。この仕様は、Red Hat Enterprise Linux で PCI デバイスの割り当てを使用するために必要です。Intel VT-d 仕様は、BIOS で有効にする必要があります。システムの製造元によっては、この仕様をデフォルトで無効にしている場合があります。これらの仕様を表示するのに使用される用語はメーカーにより異なります。適切な用語は、システムの製造元のドキュメントを参照してください。カーネルで Intel VT-d をアクティブにします。

/etc/sysconfig/grubファイル内の GRUB_CMDLINX_LINUX 行の末尾に、引用符で囲んでintel_iommu=onパラメーターおよび iommu=pt パラメーターを追加して、カーネル内で Intel VT-d をアクティブにします。以下は、Intel VT-d を有効にした修正grubです。GRUB_CMDLINE_LINUX="rd.lvm.lv=vg_VolGroup00/LogVol01 vconsole.font=latarcyrheb-sun16 rd.lvm.lv=vg_VolGroup_1/root vconsole.keymap=us $([ -x /usr/sbin/rhcrashkernel-param ] && /usr/sbin/ rhcrashkernel-param || :) rhgb quiet intel_iommu=on"設定ファイルの再生成

以下を実行して /etc/grub2.cfg を再生成します。grub2-mkconfig -o /etc/grub2.cfg

UEFI ベースのホストを使用している場合は、ターゲットファイルが/etc/grub2-efi.cfgであることに注意してください。使用準備完了

システムを再起動して、変更を有効にします。これで、システムで PCI デバイスの割り当てが可能になります。

手順9.2 PCI デバイス割り当て用の AMD システムの準備

AMD IOMMU 仕様を有効にする

Red Hat Enterprise Linux で PCI デバイスの割り当てを使用するには、AMD IOMMU の仕様が必要です。この仕様は、BIOS で有効にする必要があります。システムの製造元によっては、この仕様をデフォルトで無効にしている場合があります。IOMMU カーネルサポートの有効化

システムの起動時に AMD IOMMU 仕様が有効になるように、/etc/sysconfig/grubの GRUB_CMDLINX_LINUX 行の末尾に引用符で囲ってamd_iommu=onを追加します。設定ファイルの再生成

以下を実行して /etc/grub2.cfg を再生成します。grub2-mkconfig -o /etc/grub2.cfg

UEFI ベースのホストを使用している場合は、ターゲットファイルが/etc/grub2-efi.cfgであることに注意してください。使用準備完了

システムを再起動して、変更を有効にします。これで、システムで PCI デバイスの割り当てが可能になります。

9.1.1. virsh を使用した PCI デバイスの割り当て

pci_0000_01_00_0、および完全に仮想化されたゲストマシン guest1-rhel6-64 を持つ PCIe ネットワークコントローラーを使用します。

手順9.3 virsh を使用した PCI デバイスのゲスト仮想マシンへの割り当て

デバイスの識別

まず、仮想マシンへのデバイス割り当てに指定されている PCI デバイスを特定します。使用可能な PCI デバイスの一覧を表示する場合は、lspci コマンドを実行します。grep を使用して、lspci の出力を絞り込むことができます。この例では、以下の出力で強調表示されているイーサネットコントローラーを使用します。# lspci | grep Ethernet 00:19.0 Ethernet controller: Intel Corporation 82567LM-2 Gigabit Network Connection 01:00.0 Ethernet controller: Intel Corporation 82576 Gigabit Network Connection (rev 01) 01:00.1 Ethernet controller: Intel Corporation 82576 Gigabit Network Connection (rev 01)このイーサネットコントローラーは、短い識別子00:19.0で表示されます。この PCI デバイスを仮想マシンに割り当てるには、virsh が使用する完全な ID を確認する必要があります。これを行うには、virsh nodedev-list コマンドを使用して、ホストマシンに接続されている特定タイプ (pci) のデバイスをすべて一覧表示します。次に、使用するデバイスの短い識別子にマップする文字列の出力を調べます。この例では、短い識別子00:19.0を使用して、イーサネットコントローラーにマップする文字列を示しています。この例では、:と.が、完全な識別子では、文字はアンダースコアに置き換えられます。# virsh nodedev-list --cap pci pci_0000_00_00_0 pci_0000_00_01_0 pci_0000_00_03_0 pci_0000_00_07_0 pci_0000_00_10_0 pci_0000_00_10_1 pci_0000_00_14_0 pci_0000_00_14_1 pci_0000_00_14_2 pci_0000_00_14_3 pci_0000_00_19_0 pci_0000_00_1a_0 pci_0000_00_1a_1 pci_0000_00_1a_2 pci_0000_00_1a_7 pci_0000_00_1b_0 pci_0000_00_1c_0 pci_0000_00_1c_1 pci_0000_00_1c_4 pci_0000_00_1d_0 pci_0000_00_1d_1 pci_0000_00_1d_2 pci_0000_00_1d_7 pci_0000_00_1e_0 pci_0000_00_1f_0 pci_0000_00_1f_2 pci_0000_00_1f_3 pci_0000_01_00_0 pci_0000_01_00_1 pci_0000_02_00_0 pci_0000_02_00_1 pci_0000_06_00_0 pci_0000_07_02_0 pci_0000_07_03_0使用するデバイスにマップする PCI デバイス番号を記録します。これは別の手順で必要になります。デバイス情報の確認

ドメイン、バス、および機能の情報は、virsh nodedev-dumpxml コマンドの出力から取得できます。virsh nodedev-dumpxml pci_0000_00_19_0 <device> <name>pci_0000_00_19_0</name> <parent>computer</parent> <driver> <name>e1000e</name> </driver> <capability type='pci'> <domain>0</domain> <bus>0</bus> <slot>25</slot> <function>0</function> <product id='0x1502'>82579LM Gigabit Network Connection</product> <vendor id='0x8086'>Intel Corporation</vendor> <iommuGroup number='7'> <address domain='0x0000' bus='0x00' slot='0x19' function='0x0'/> </iommuGroup> </capability> </device>注記IOMMU グループは、IOMMU からの視認性とデバイスの分離に基づいて決定されます。各 IOMMU グループには、1 つ以上のデバイスを含めることができます。複数のデバイスが存在する場合は、グループ内のすべてのデバイスがゲストに割り当てられるため、IOMMU グループ内のすべてのエンドポイントが要求されます。これは、追加のエンドポイントをゲストに割り当てるか、virsh nodedev-detach を使用してホストドライバーから外すことで実行できます。1 つのグループに含まれるデバイスが複数のゲストに分割されたり、ホストとゲストが分割されたりすることはありません。PCIe root ポート、スイッチポート、ブリッジなどのエンドポイント以外のデバイスは、ホストドライバーから分離しないでください。また、エンドポイントの割り当てに影響を及ぼしません。IOMMU グループ内のデバイスは、virsh nodedev-dumpxml 出力の IOMMU グループセクションを使用して決定できます。グループの各メンバーは、別のアドレスフィールドで提供されます。この情報は、sysfs で以下を使用して取得することもできます。$ ls /sys/bus/pci/devices/0000:01:00.0/iommu_group/devices/

この出力の例を以下に示します。0000:01:00.0 0000:01:00.1

ゲストに 0000.01.00.0 のみを割り当てるには、ゲストを起動する前に、使用されていないエンドポイントをホストから分離する必要があります。$ virsh nodedev-detach pci_0000_01_00_1

必要な設定の詳細を決定する

設定ファイルに必要な値は、virsh nodedev-dumpxml pci_0000_00_19_0 コマンドの出力を参照してください。この例のデバイスは、bus = 0、slot = 25、および function = 0 の値を持ちます。10 進数の設定では、この 3 つの値が使用されます。bus='0' slot='25' function='0'

設定の詳細の追加

virsh edit を実行し、仮想マシン名を指定し、<source>セクションにデバイスエントリーを追加して、PCI デバイスをゲスト仮想マシンに割り当てます。# virsh edit guest1-rhel6-64 <hostdev mode='subsystem' type='pci' managed='yes'> <source> <address domain='0' bus='0' slot='25' function='0'/> </source> </hostdev>または、virsh attach-device を実行して、仮想マシンの名前とゲストの XML ファイルを指定します。virsh attach-device guest1-rhel6-64

file.xml仮想マシンの起動

# virsh start guest1-rhel6-64

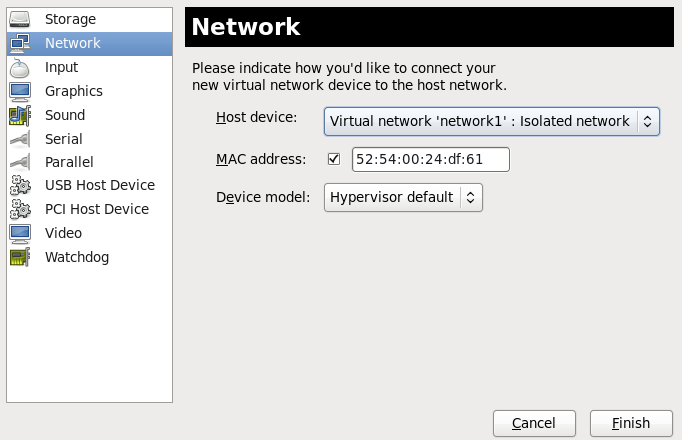

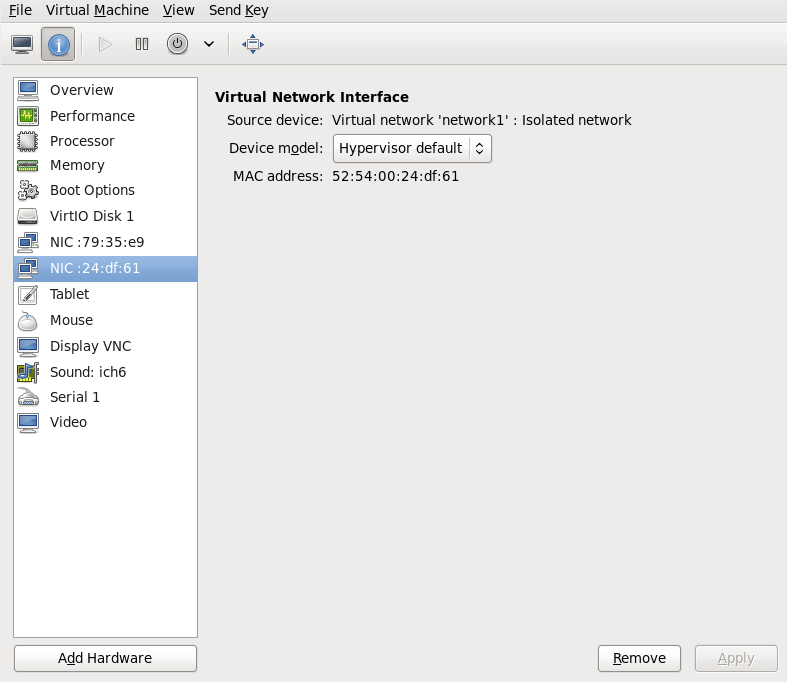

9.1.2. virt-manager を使用した PCI デバイスの割り当て

手順9.4 virt-manager を使用した PCI デバイスのゲスト仮想マシンへの割り当て

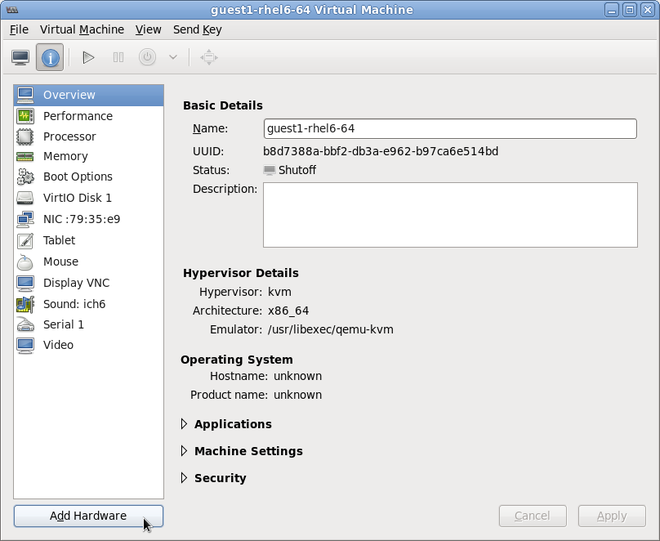

ハードウェア設定を開く

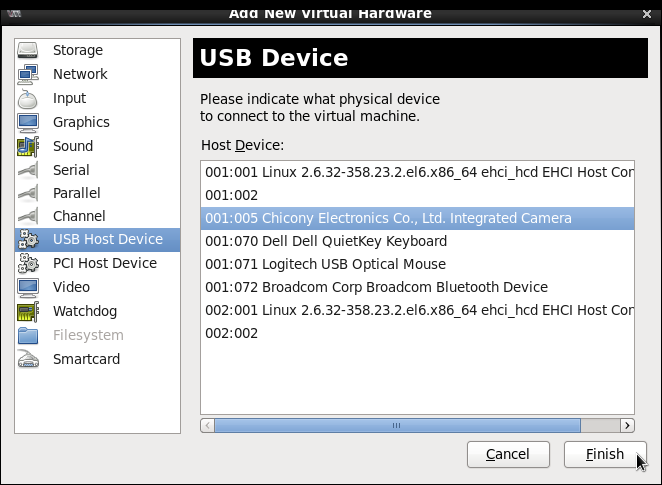

ゲスト仮想マシンを開き、Add Hardware をクリックして、仮想マシンに新しいデバイスを追加します。図9.1 仮想マシンのハードウェア情報ウィンドウ

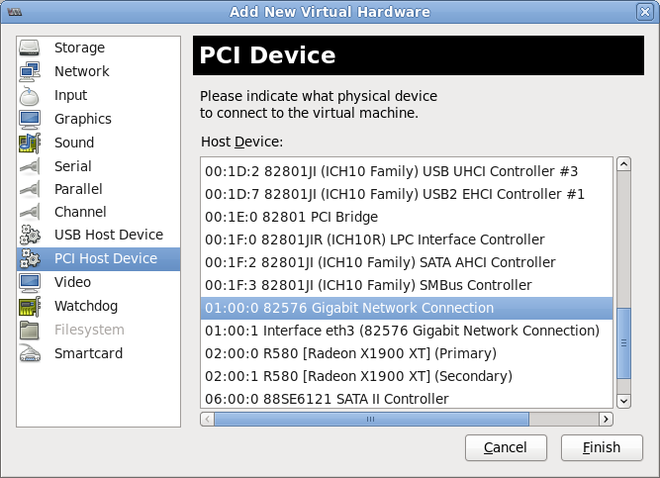

PCI デバイスの選択

左側の Hardware 一覧から PCI Host Device を選択します。未使用の PCI デバイスを選択します。別のゲストが使用している PCI デバイスを選択すると、エラーが発生する可能性があります。この例では、予備の 82576 ネットワークデバイスが使用されています。Finish を選択して設定を完了します。図9.2 Add new virtual hardware ウィザード

新しいデバイスの追加

セットアップが完了し、ゲスト仮想マシンが PCI デバイスに直接アクセスできるようになりました。図9.3 仮想マシンのハードウェア情報ウィンドウ

9.1.3. virt-install を使用した PCI デバイスの割り当て

--host-device パラメーターを使用します。

手順9.5 virt-install を使用した、仮想マシンへの PCI デバイスの割り当て

デバイスの識別

ゲスト仮想マシンにデバイス割り当てに指定されている PCI デバイスを特定します。# lspci | grep Ethernet 00:19.0 Ethernet controller: Intel Corporation 82567LM-2 Gigabit Network Connection 01:00.0 Ethernet controller: Intel Corporation 82576 Gigabit Network Connection (rev 01) 01:00.1 Ethernet controller: Intel Corporation 82576 Gigabit Network Connection (rev 01)

virsh nodedev-list コマンドは、システムに接続されているすべてのデバイスの一覧を表示し、各 PCI デバイスを文字列で識別します。出力を PCI デバイスのみに制限するには、次のコマンドを実行します。# virsh nodedev-list --cap pci pci_0000_00_00_0 pci_0000_00_01_0 pci_0000_00_03_0 pci_0000_00_07_0 pci_0000_00_10_0 pci_0000_00_10_1 pci_0000_00_14_0 pci_0000_00_14_1 pci_0000_00_14_2 pci_0000_00_14_3 pci_0000_00_19_0 pci_0000_00_1a_0 pci_0000_00_1a_1 pci_0000_00_1a_2 pci_0000_00_1a_7 pci_0000_00_1b_0 pci_0000_00_1c_0 pci_0000_00_1c_1 pci_0000_00_1c_4 pci_0000_00_1d_0 pci_0000_00_1d_1 pci_0000_00_1d_2 pci_0000_00_1d_7 pci_0000_00_1e_0 pci_0000_00_1f_0 pci_0000_00_1f_2 pci_0000_00_1f_3 pci_0000_01_00_0 pci_0000_01_00_1 pci_0000_02_00_0 pci_0000_02_00_1 pci_0000_06_00_0 pci_0000_07_02_0 pci_0000_07_03_0

PCI デバイス番号を記録します。この番号は他の手順で確認する必要があります。ドメイン、バス、および機能の情報は、virsh nodedev-dumpxml コマンドの出力から取得できます。# virsh nodedev-dumpxml pci_0000_01_00_0 <device> <name>pci_0000_01_00_0</name> <parent>pci_0000_00_01_0</parent> <driver> <name>igb</name> </driver> <capability type='pci'> <domain>0</domain> <bus>1</bus> <slot>0</slot> <function>0</function> <product id='0x10c9'>82576 Gigabit Network Connection</product> <vendor id='0x8086'>Intel Corporation</vendor> <iommuGroup number='7'> <address domain='0x0000' bus='0x00' slot='0x19' function='0x0'/> </iommuGroup> </capability> </device>注記IOMMU グループに複数のエンドポイントがあり、そのすべてがゲストに割り当てられていない場合は、ゲストを起動する前に次のコマンドを実行して、ホストからその他のエンドポイントの割り当てを手動で解除する必要があります。$ virsh nodedev-detach pci_0000_00_19_1

IOMMU グループの詳細は、「virsh を使用した PCI デバイスの割り当て」 の 注記 を参照してください。デバイスの追加

virshnodedev コマンドから出力された PCI 識別子を--host-deviceパラメーターの値として使用します。virt-install \ --name=guest1-rhel6-64 \ --disk path=/var/lib/libvirt/images/guest1-rhel6-64.img,size=8 \ --nonsparse --graphics spice \ --vcpus=2 --ram=2048 \ --location=http://example1.com/installation_tree/RHEL6.0-Server-x86_64/os \ --nonetworks \ --os-type=linux \ --os-variant=rhel6 --host-device=pci_0000_01_00_0インストールを完了する

ゲストのインストールを完了します。PCI デバイスはゲストに接続する必要があります。

9.1.4. 割り当てられた PCI デバイスの取り外し

手順9.6 virsh を使用したゲストからの PCI デバイスの切り離し

デバイスの取り外し

次のコマンドを使用して、ゲストの XML ファイルから PCI デバイスを削除し、ゲストから PCI デバイスを切り離します。# virsh detach-device name_of_guest file.xml

デバイスをホストに再接続します (オプション)。

デバイスがmanagedモードにある場合は、この手順を省略します。デバイスは自動的にホストに戻ります。デバイスがmanagedモードを使用していない場合は、以下のコマンドを使用して PCI デバイスをホストマシンに再接続します。# virsh nodedev-reattach device

たとえば、pci_0000_01_00_0デバイスーをホストコンピューターに再接続するには、次のコマンドを実行します。virsh nodedev-reattach pci_0000_01_00_0

これで、デバイスがホストで使用できるようになります。

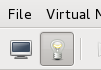

手順9.7 virt-manager を使用したゲストからの PCI デバイスの切り離し

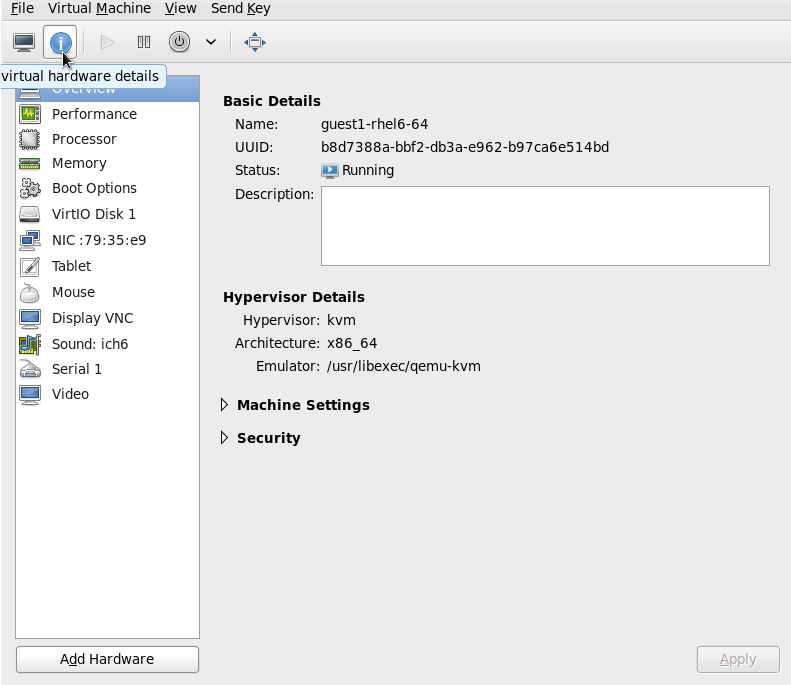

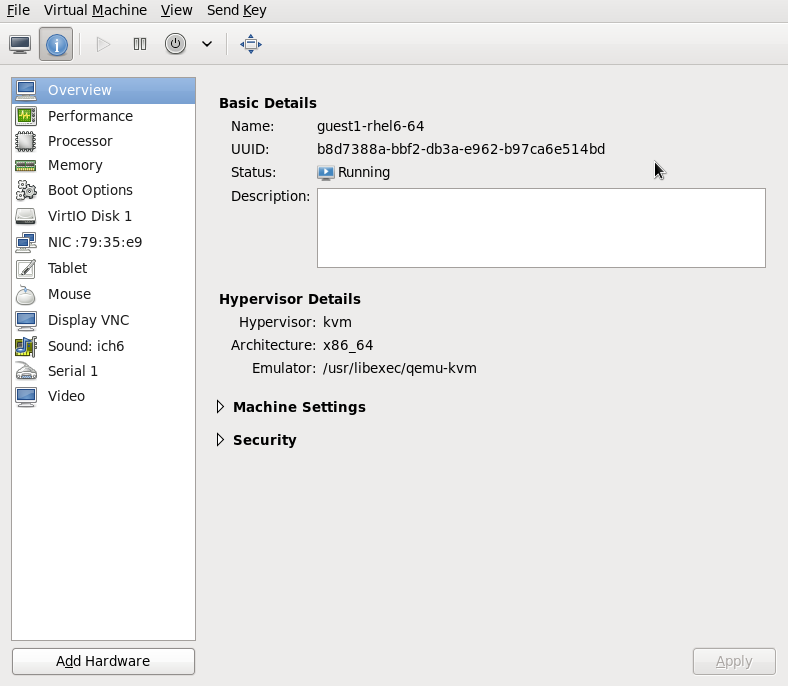

仮想ハードウェアの詳細画面を開きます。

virt-manager で、デバイスを含む仮想マシンをダブルクリックします。Show virtual hardware details ボタンを選択すると、仮想ハードウェアの一覧が表示されます。図9.4 仮想ハードウェアの詳細ボタン

デバイスを選択して削除する

左側のパネルにある仮想デバイスの一覧から、取り外す PCI デバイスを選択します。図9.5 取り外す PCI デバイスの選択

Remove ボタンをクリックして確定します。これで、デバイスがホストで使用できるようになります。

Remove ボタンをクリックして確定します。これで、デバイスがホストで使用できるようになります。

9.1.5. PCI ブリッジの作成

9.1.6. PCI パススルー

<source> 要素で指定される PCI ネットワークデバイスは、ジェネリックデバイスパススルーを使用してゲストに直接割り当てられます。このデバイスの MAC アドレスは、最初にオプションで設定された値に設定され、そのデバイスの MAC アドレスがオプションで指定された virtualport 要素を使用して 802.1Qbh 対応スイッチに関連付けられます (<type='direct'> ネットワークデバイスの場合は、上記の仮想ポートの例を参照してください)。標準的なシングルポートの PCI イーサネットカードドライバー設計の制限により、この方法で割り当てることができるのは Single Root I/O Virtualization (SR-IOV) virtual function (VF) デバイスのみとなります。標準的なシングルポートの PCI または PCIe イーサネットカードをゲストに割り当てる場合は、従来の <hostdev> デバイス定義を使用します。

<type='hostdev'> インターフェイスは name 属性を持つオプションのドライバーサブ要素を持つことができます vfio に設定します。従来の KVM デバイス割り当てを使用するには、名前を kvm に設定できます (または、現在、<driver ='kvm'> がデフォルトであるため、単に <driver> 要素を省略します)。

<hostdev> デバイスの機能と非常に似ています。相違点は、パススルーデバイスに MAC アドレスと<virtualport>を指定できることです。これらの機能が必要ない場合、SR-IOV をサポートしない標準のシングルポート PCI、PCIe、または USB ネットワークカードを使用している場合 (したがって、ゲストドメインに割り当てられた後、リセット中に設定された MAC アドレスが失われます)、または 0.9.11 より前のバージョンの libvirt を使用している場合は、<interface type='hostdev'/> の代わりに、標準の <hostdev> を使用してデバイスをゲストに割り当てる必要があります。

図9.6 PCI デバイスの割り当ての XML 例

<devices>

<interface type='hostdev'>

<driver name='vfio'/>

<source>

<address type='pci' domain='0x0000' bus='0x00' slot='0x07' function='0x0'/>

</source>

<mac address='52:54:00:6d:90:02'>

<virtualport type='802.1Qbh'>

<parameters profileid='finance'/>

</virtualport>

</interface>

</devices>9.1.7. SR-IOV デバイスを使用した PCI 割り当て (パススルー) の設定

<hostdev> 要素を使用して割り当てることができますが、SR-IOV VF ネットワークデバイスには永続的な一意の MAC アドレスがないため、ホストの物理マシンを再起動するたびにゲスト仮想マシンのネットワーク設定を再設定する必要があります。これを解決するには、VF をホスト物理マシンに割り当てる前に MAC アドレスを設定する必要があり、ゲスト仮想マシンが起動するたびにこれを設定する必要があります。この MAC アドレスやその他のオプションを割り当てるには、手順9.8「SR-IOV で PCI デバイスを割り当てる MAC アドレス、vLAN、および仮想ポートの設定」の手順を参照してください。

手順9.8 SR-IOV で PCI デバイスを割り当てる MAC アドレス、vLAN、および仮想ポートの設定

<mac>、<vlan>、および <virtualport> 要素は <hostdev> の有効な子ではないため、<hostdev> 要素は MAC アドレス割り当て、vLAN タグ ID 割り当て、仮想ポート割り当てなどの機能固有の項目には使用できないことに注意してください。これらは <インターフェイス> で有効であるため、新しいインターフェイスタイプのサポートが追加されました (<interface type='hostdev'>)。この新しいインターフェイスデバイスタイプは、<インターフェイス> と <hostdev> のハイブリッドとして動作します。そのため、libvirt は、ゲスト仮想マシンに PCI デバイスを割り当てる前に、ゲスト仮想マシンの XML 設定ファイルに示されているネットワーク固有のハードウェア/スイッチを初期化します (MAC アドレスの設定、vLAN タグの設定、802.1Qbh スイッチへの関連付けなど)。vLAN タグの設定に関する詳細は、「vLAN タグの設定」 を参照してください。

ゲスト仮想マシンをシャットダウンします。

virsh shutdown コマンドの使用 (「ゲスト仮想マシンのシャットダウン」 を参照)、guestVM という名前のゲスト仮想マシンをシャットダウンします。# virsh shutdown guestVM情報の収集

<interface type='hostdev'>を使用するには、SR-IOV 対応のネットワークカード、Intel VT-d 拡張機能または AMD IOMMU 拡張機能に対応するホストの物理マシンハードウェアが必要で、割り当てる VF の PCI アドレスを把握している必要があります。編集する XML ファイルを開く

# virsh save-image-edit コマンドを実行し、XML ファイルを編集用に開きます (詳細は 「ドメイン XML 設定ファイルの編集」 を参照してください)。ゲスト仮想マシンを以前の実行状態に復元する必要があるため、この場合は--runningが使用されます。この例の設定ファイルの名前は guestVM.xml です。ゲスト仮想マシンの名前は guestVM です。# virsh save-image-edit guestVM.xml--runningguestVM.xmlがデフォルトのエディターで開きます。XML ファイルの編集

設定ファイル (guestVM.xml) を更新して、以下のような<devices>エントリーが表示されるようにします。図9.7 hostdev インターフェイスタイプのサンプルドメイン XML

<devices> ... <interface type='hostdev' managed='yes'> <source> <address type='pci' domain='0x0' bus='0x00' slot='0x07' function='0x0'/> <!--these values can be decimal as well--> </source> <mac address='52:54:00:6d:90:02'/> <!--sets the mac address--> <virtualport type='802.1Qbh'> <!--sets the virtual port for the 802.1Qbh switch--> <parameters profileid='finance'/> </virtualport> <vlan> <!--sets the vlan tag--> <tag id='42'/> </vlan> </interface> ... </devices>MAC アドレスを指定しないと、その他のタイプのインターフェイスデバイスと同様に、MAC アドレスが自動的に生成されることに注意してください。また、<virtualport>要素は、802.11Qgh ハードウェアスイッチ(802.11Qbg)に接続する場合にのみ使用されます。"VEPA")スイッチは現在サポートされていません。ゲスト仮想マシンの再起動

virsh start コマンドを実行して、最初の手順でシャットダウンしたゲスト仮想マシンを再起動します (例では、ゲスト仮想マシンのドメイン名として guestVM を使用します)。詳細は、「定義済みドメインの開始」 を参照してください。# virsh start guestVMゲスト仮想マシンは起動時に、設定された MAC アドレスを持つ、物理ホストマシンのアダプターにより提供されたネットワークデバイスを認識します。この MAC アドレスは、ゲスト仮想マシンやホストの物理マシンを再起動しても変更されません。

9.1.8. SR-IOV 仮想機能のプールからの PCI デバイス割り当ての設定

- 指定の VF は、ゲスト仮想マシンが起動したときにいつでも利用できる必要があります。つまり、管理者は、各 VF を 1 つのゲスト仮想マシンに永続的に割り当てる必要があります (または、各ゲスト仮想マシンの設定ファイルを変更して、ゲスト仮想マシンが起動するたびに現在使用されていない VF の PCI アドレスを指定します)。

- ゲスト仮想マシンを別のホスト物理マシンに移動する場合は、そのホスト物理マシンのハードウェアが PCI バス上の同じ場所にある必要があります (または、ゲスト仮想マシンの設定を起動前に変更する必要があります)。

手順9.9 デバイスプールの作成

ゲスト仮想マシンをシャットダウンします。

virsh shutdown コマンドの使用 (「ゲスト仮想マシンのシャットダウン、再起動、および強制シャットダウン」 を参照)、guestVM という名前のゲスト仮想マシンをシャットダウンします。# virsh shutdown guestVM設定ファイルの作成

任意のエディターを使用して、/tmpディレクトリーに XML ファイル (名前は passthrough.xml など) を作成します。pf dev='eth3'を、ご使用の SR-IOV デバイスの PF の netdev 名に置き換えてください。以下は、ホスト物理マシンの "eth3' にある physical function (PF) を持つ SR-IOV アダプターのすべての VF のプールを使用できるようにするネットワーク定義の例です。図9.8 サンプルのネットワーク定義ドメイン XML

<network> <name>passthrough</name> <!--This is the name of the file you created--> <forward mode='hostdev' managed='yes'> <pf dev='myNetDevName'/> <!--Use the netdev name of your SR-IOV devices PF here--> </forward> </network>新しい XML ファイルの読み込み

/tmp/passthrough.xml を、前の手順で作成した XML ファイルの名前と場所に置き換え、次のコマンドを実行します。# virsh net-define /tmp/passthrough.xmlゲストの再起動

以下の passthrough.xml を、前の手順で作成した XML ファイルの名前に置き換えます。# virsh net-autostart passthrough # virsh net-start passthrough

ゲスト仮想マシンの再起動

virsh start コマンドを実行して、最初の手順でシャットダウンしたゲスト仮想マシンを再起動します (例では、ゲスト仮想マシンのドメイン名として guestVM を使用します)。詳細は、「定義済みドメインの開始」 を参照してください。# virsh start guestVMデバイスのパススルーの開始

表示されているデバイスは 1 つだけですが、libvirt は、ゲスト仮想マシンが次のようなドメイン XML のインターフェイス定義で初めて起動されたときに、その PF に関連付けられているすべての VF のリストを自動的に取得します。図9.9 インターフェイスネットワーク定義のサンプルドメイン XML

<interface type='network'> <source network='passthrough'> </interface>検証

ネットワークを使用する最初のゲストを起動したら、virsh net-dumpxml passthrough コマンドを実行し、これを確認できます。以下のような出力が得られます。図9.10 XML ダンプファイルのpassthroughコンテンツ

<network connections='1'> <name>passthrough</name> <uuid>a6b49429-d353-d7ad-3185-4451cc786437</uuid> <forward mode='hostdev' managed='yes'> <pf dev='eth3'/> <address type='pci' domain='0x0000' bus='0x02' slot='0x10' function='0x1'/> <address type='pci' domain='0x0000' bus='0x02' slot='0x10' function='0x3'/> <address type='pci' domain='0x0000' bus='0x02' slot='0x10' function='0x5'/> <address type='pci' domain='0x0000' bus='0x02' slot='0x10' function='0x7'/> <address type='pci' domain='0x0000' bus='0x02' slot='0x11' function='0x1'/> <address type='pci' domain='0x0000' bus='0x02' slot='0x11' function='0x3'/> <address type='pci' domain='0x0000' bus='0x02' slot='0x11' function='0x5'/> </forward> </network>

9.2. USB デバイス

9.2.1. ゲスト仮想マシンへの USB デバイスの割り当て

- USB パススルーを使用する - これにより、デバイスが、ゲスト仮想マシンをホストしているホストの物理マシンに物理的に接続されます。この場合は SPICE は必要ありません。ホストの USB デバイスは、コマンドラインまたは virt-manager を使用してゲストに渡すことができます。virt manager の方向については、「ゲスト仮想マシンへの USB デバイスの接続」 を参照してください。注記virt-manager は、ホットプラグまたはホットアンプラグデバイスに使用しないでください。USB デバイスをホットプラグまたはホットアンプラグする場合は、手順14.1「ゲスト仮想マシンが使用するホットプラグ USB デバイス」 を参照してください。

- USB リダイレクトの使用 - USB リダイレクトは、データセンターで実行されているホスト物理マシンがある場合に最適です。ユーザーは、ローカルマシンまたはシンクライアントからゲスト仮想マシンに接続します。このローカルマシンには SPICE クライアントがあります。ユーザーは、任意の USB デバイスをシンクライアントに接続できます。SPICE クライアントは、デバイスをデータセンターのホスト物理マシンにリダイレクトするため、シンクライアントで実行しているゲスト仮想マシンで使用できます。virt-manager を使用した USB リダイレクトの手順については、「ゲスト仮想マシンへの USB デバイスの接続」 を参照してください。TCP プロトコルを使用した USB リダイレクトはできないことに注意してください (BZ#1085318 を参照)。

9.2.2. USB デバイスリダイレクトの制限の設定

-device usb-redir に渡します。filter プロパティーは、フィルタールールで設定される文字列を取ります。ルールの形式は以下のとおりです。

<class>:<vendor>:<product>:<version>:<allow>-1 の値を使用して、特定のフィールドに任意の値を受け入れるように指定します。同じコマンドラインで、| を区切り文字として使用し、複数のルールを使用できます。

例9.1 Windows ゲスト仮想マシンを使用したリダイレクトを制限する例

- Windows 7 ゲスト仮想マシンを準備します。

- 以下のコード抜粋をゲスト仮想マシンのドメイン xml ファイルに追加します。

<redirdev bus='usb' type='spicevmc'> <alias name='redir0'/> <address type='usb' bus='0' port='3'/> </redirdev> <redirfilter> <usbdev class='0x08' vendor='0x1234' product='0xBEEF' version='2.0' allow='yes'/> <usbdev class='-1' vendor='-1' product='-1' version='-1' allow='no'/> </redirfilter> - ゲスト仮想マシンを起動し、次のコマンドを実行して設定の変更を確認します。

#ps -ef | grep $guest_name-device usb-redir,chardev=charredir0,id=redir0,/ filter=0x08:0x1234:0xBEEF:0x0200:1|-1:-1:-1:-1:0,bus=usb.0,port=3

- USB デバイスをホストの物理マシンに接続し、virt-manager を使用してゲスト仮想マシンに接続します。

- メニューで Redirect USB Service をクリックすると、Some USB devices are blocked by host policy というメッセージが表示されます。OK をクリックして確定し、続行します。フィルターが有効になります。

- フィルターが正しくキャプチャーされていることを確認するには、USB デバイスのベンダーと製品を確認してから、USB リダイレクトを可能にするために、テストの仮想マシンのドメイン XML で次の変更を行います。

<redirfilter> <usbdev class='0x08' vendor='0x0951' product='0x1625' version='2.0' allow='yes'/> <usbdev allow='no'/> </redirfilter> - ゲスト仮想マシンを再起動してから、virt-viewer を使用してゲスト仮想マシンに接続します。これで、USB デバイスはトラフィックをゲスト仮想マシンにリダイレクトするようになります。

9.3. デバイスコントローラーの設定

図9.11 仮想コントローラーのドメイン XML の例

...

<devices>

<controller type='ide' index='0'/>

<controller type='virtio-serial' index='0' ports='16' vectors='4'/>

<controller type='virtio-serial' index='1'>

<address type='pci' domain='0x0000' bus='0x00' slot='0x0a' function='0x0'/>

</controller>

...

</devices>

...

<controller type> があり、これは次のいずれかになります。

- ide

- fdc

- scsi

- sata

- usb

- ccid

- virtio-serial

- pci

<controller> 要素には必須の属性 <controller index> があります。これは、バスコントローラーが発生した順序を表す 10 進数の整数です (<address> 要素のコントローラー属性で使用されます)。<controller type ='virtio-serial'> には、追加のオプション属性 (ports および vectors) が 2 つあります。これは、コントローラーを介して接続できるデバイスの数を制御します。Red Hat Enterprise Linux 6 は、デバイスあたり 32 を超えるベクターの使用をサポートしていないことに注意してください。よりベクトルを使用すると、ゲスト仮想マシンの移行でエラーが発生します。

<controller type ='scsi'> の場合、以下の値を持つことができる任意の属性model モデルがあります。

- auto

- buslogic

- ibmvscsi

- lsilogic

- lsisas1068

- lsisas1078

- virtio-scsi

- vmpvscsi

<controller type ='usb'> の場合、以下の値を持つことができる任意の属性model モデルがあります。

- piix3-uhci

- piix4-uhci

- ehci

- ich9-ehci1

- ich9-uhci1

- ich9-uhci2

- ich9-uhci3

- vt82c686b-uhci

- pci-ohci

- nec-xhci

<model='none'> を使用できます。 .

<address> は、「デバイスのアドレスの設定」 に示したセマンティクスを使用して、コントローラーとマスターバスの正確な関係を指定できます。

<driver> は、ドライバー固有のオプションを指定できます。現在、コントローラーのキューの数を指定する属性キューのみをサポートしています。パフォーマンスを最適化するには、vCPU の数に一致する値を指定することが推奨されます。

<master> があります。コンパニオンコントローラーはマスターと同じバスにあるため、コンパニオン index は等しい値になります。

図9.12 USB コントローラーのドメイン XML の例

...

<devices>

<controller type='usb' index='0' model='ich9-ehci1'>

<address type='pci' domain='0' bus='0' slot='4' function='7'/>

</controller>

<controller type='usb' index='0' model='ich9-uhci1'>

<master startport='0'/>

<address type='pci' domain='0' bus='0' slot='4' function='0' multifunction='on'/>

</controller>

...

</devices>

...

model 属性があります。

- pci-root

- pcie-root

- pci-bridge

- dmi-to-pci-bridge

pci-root および pcie-root) には、64 ビット PCI ホールの大きさ (キロバイト単位、または pcihole64 の unit 属性で指定された単位) を指定するオプションの pcihole64 要素があります。一部のゲスト仮想マシン (Windows Server 2003) は、unit が無効になっていない限り (0 unit='0' に設定)、クラッシュを引き起こす可能性があります。

index='0' を使用する pci-root コントローラーは自動追加され、PCI デバイスを使用する必要があります。pci-root にはアドレスがありません。PCI ブリッジは、model='pci-root' が提供する 1 つのバスに収まらないデバイスが多すぎる場合、または 0 を超える PCI バス番号が指定されている場合に自動追加されます。PCI ブリッジは手動で指定することもできますが、そのアドレスには、指定されている PCI コントローラーが提供する PCI バスのみが表示されるようにしてください。PCI コントローラーインデックスにギャップがあると、設定が無効になる場合があります。以下の XML サンプルは、<devices> セクションに追加できます。

図9.13 PCI ブリッジのドメイン XML の例

...

<devices>

<controller type='pci' index='0' model='pci-root'/>

<controller type='pci' index='1' model='pci-bridge'>

<address type='pci' domain='0' bus='0' slot='5' function='0' multifunction='off'/>

</controller>

</devices>

...

index='0' を使用する pcie-root コントローラーはドメインの設定に自動的に追加されます。pcie-root にはアドレスはありませんが、31 スロット (1-31 の番号) を提供し、PCIe デバイスの接続にのみ使用できます。pcie-root コントローラーを持つシステムで標準的な PCI デバイスを接続するには、model='dmi-to-pci-bridge' を持つ pci コントローラーが自動的に追加されます。dmi-to-pci-bridge コントローラーは、(pcie-root が提供するように) PCIe スロットに接続し、それ自体で 31 個の標準的な PCI スロットを提供します (これはホットプラグできません)。ゲストシステムにホットプラグ可能な PCI スロットを確保するために、pci-bridge コントローラーも自動的に作成され、自動作成された dmi-to-pci-bridge コントローラーのスロットの 1 つに接続されます。PCI アドレスが libvirt により自動決定されるすべてのゲストデバイスは、この pci-bridge デバイスに配置されます。

図9.14 PCIe (PCI express) のようなドメイン XML

...

<devices>

<controller type='pci' index='0' model='pcie-root'/>

<controller type='pci' index='1' model='dmi-to-pci-bridge'>

<address type='pci' domain='0' bus='0' slot='0xe' function='0'/>

</controller>

<controller type='pci' index='2' model='pci-bridge'>

<address type='pci' domain='0' bus='1' slot='1' function='0'/>

</controller>

</devices>

...

9.4. デバイスのアドレスの設定

<address> サブ要素があります。入力でアドレス (またはアドレス内の任意の属性) が省略された場合 libvirt は適切なアドレスを生成します。レイアウトをさらに制御する必要がある場合は明示的なアドレスが必要になります。<address> 要素を含むドメイン XML デバイスの例は、図9.6「PCI デバイスの割り当ての XML 例」 を参照してください。

type があります。特定のデバイスに使用するアドレスの選択は、デバイスやゲスト仮想マシンのアーキテクチャーによって一部が制約されます。たとえば、<disk> デバイスは type='drive' を使用し、<console> デバイスは i686 または x86_64 ゲスト仮想マシンアーキテクチャー で type='pci' を使用します。各アドレスタイプには、表に記載されているように、バス上のどこにデバイスを配置するかを制御するオプションの属性がさらにあります。

表9.1 サポートされているデバイスのアドレスタイプ

| アドレスの種類 | 説明 |

|---|---|

| type='pci' | PCI アドレスには、以下の追加属性があります。

|

| type='drive' | ドライブアドレスには、以下の追加属性があります。

|

| type='virtio-serial' | 各 virtio-serial アドレスには、以下の追加属性があります。

|

| type='ccid' | スマートカード用の CCID アドレスには、以下の追加属性があります。

|

| type='usb' | USB アドレスには、以下の追加属性があります。

|

| type='isa' | ISA アドレスには、以下の追加属性があります。

|

9.5. ゲスト仮想マシンでのストレージコントローラーの管理

- virtio-scsi コントローラーを介して仮想ハードドライブまたは CD を接続します。

- QEMU scsi-block デバイスを介してホストからゲストに物理 SCSI デバイスをパススルーします。

- ゲストごとに数百台のデバイスを使用できるようにします。virtio-blk の 28 デバイスの制限からの改善。

手順9.10 仮想 SCSI コントローラーの作成

- ゲスト仮想マシン (

Guest1) の設定を表示し、以前から存在している SCSI コントローラーを検索します。# virsh dumpxml Guest1 | grep controller.*scsi

デバイスコントローラーが存在する場合は、このコマンドにより、次のような行が 1 つ以上出力されます。<controller type='scsi' model='virtio-scsi' index='0'/>

- 前の手順でデバイスコントローラーが表示されなかった場合は、以下の手順に従って、新しいファイルにデバイスコントローラーの説明を作成し、仮想マシンに追加します。

- 新しいファイルに

<controller>要素を書き込んでデバイスコントローラーを作成し、このファイルに XML 拡張子で保存します。virtio-scsi-controller.xmlなど。<controller type='scsi' model='virtio-scsi'/>

virtio-scsi-controller.xmlで作成したデバイスコントローラーをゲスト仮想マシン (例: Guest1) に関連付けます。# virsh attach-device --config Guest1 ~/virtio-scsi-controller.xml

この例では、--configオプションはディスクと同じように動作します。詳細は、手順13.2「ゲストへの物理ブロックデバイスの追加」 を参照してください。

- 新しい SCSI ディスクまたは CD-ROM を追加します。新しいディスクは、「 ゲストへのファイルベースストレージの追加」 セクションおよび 「ゲストへのハードドライブおよびその他のブロックデバイスの追加」 セクションの方法を使用して追加できます。SCSI ディスクを作成する場合は、sd で始まるターゲットデバイス名を指定します。

# virsh attach-disk Guest1 /var/lib/libvirt/images/FileName.img sdb --cache none

ゲスト仮想マシンのドライバーのバージョンによっては、実行中のゲスト仮想マシンで新しいディスクがすぐに検出されない場合があります。『Red Hat Enterprise Linux Storage Administration Guide』 の手順に従います。

9.6. 乱数ジェネレーター (RNG) デバイス

virtio-rng は、仮想 RNG (random number generator) デバイスであり、RNG データをゲスト仮想マシンのオペレーティングシステムにフィードします。これにより、要求に応じてゲスト仮想マシンに新しいエントロピーを提供します。

virtio-rng が有効になっている場合、chardev はゲスト仮想マシンの /dev/hwrng/ の場所に作成されます。次に、この文字 dev を開いて読み取り、ホストの物理マシンからエントロピーをフェッチできます。ゲスト仮想マシンのアプリケーションが virtio-rng デバイスからのランダム性を透過的に使用することで利益を得るには、/dev/hwrng/ からの入力をゲスト仮想マシンのカーネルエントロピープールに中継する必要があります。これは、この場所の情報が rgnd デーモン (rng-tools 内に含まれている) と結合されている場合に実行できます。

/dev/random ファイルにルーティングされます。このプロセスは、Red Hat Enterprise Linux 6 ゲスト仮想マシンで手動で行います。

# rngd -b -r /dev/hwrng/ -o /dev/random/

viorng をインストールする必要があります。インストールが完了すると、仮想 RNG デバイスは Microsoft が提供する CNG(手動生成)API を使用して機能します。ドライバーがインストールされると、virtrng デバイスが RNG プロバイダーのリストに表示されます。

手順9.11 コマンドラインツールでの virtio-rng の実装

- ゲスト仮想マシンをシャットダウンします。

- ターミナルウィンドウで、virsh edit domain-name コマンドを使用して、目的のゲスト仮想マシンの XML ファイルを開きます。

<devices>要素を編集して、以下の内容を追加します。... <devices> <rng model='virtio'> <rate period="2000" bytes="1234"/> <backend model='random'>/dev/random</backend> <source mode='bind' service='1234'> <source mode='connect' host='192.0.2.1' service='1234'> </backend> </rng> </devices> ...

第10章 qemu-img および QEMU ゲストエージェント

/usr/share/doc/qemu-*/README.systemtap。

10.1. qemu-img の使用

チェック

ディスクイメージの filename で整合性チェックを実行します。

# qemu-img check -f qcow2 --output=qcow2 -r all filename-img.qcow2

qcow2 および vdi 形式のみが整合性チェックに対応します。

-r を使用すると、チェック中に見つかった不整合を修復しようとしますが、-r leaks クラスターのリークで使用されると修復され、-r all ですべての種類のエラーが修正されます。これには、間違った修正を選択したり、すでに発生している可能性のある破損の問題を隠したりするリスクがあることに注意してください。

Commit

指定したイメージファイル (filename) に記録された変更を、qemu-img commit コマンドでファイルのベースイメージにコミットします。オプションで、ファイルのフォーマットタイプ (format) を指定します。

# qemu-img commit [-fformat] [-tcache] filename

convert

convert オプションは、認識されているイメージ形式を別のイメージ形式に変換するために使用されます。

# qemu-img convert [-c] [-p] [-fformat] [-tcache] [-Ooutput_format] [-ooptions] [-Ssparse_size] filename output_filename

-p パラメーターはコマンドの進捗を示し (すべてのコマンドではなく任意)、-S フラグは、ディスクイメージに含まれる sparse file の作成を許可します。ゼロのみを含む (何も含まない) 物理ブロックを除いて、あらゆる目的のスパースファイルは標準ファイルのように機能します。オペレーティングシステムがこのファイルを認識すると、たとえ実際にはディスクを使用していなくても、存在しているものとして扱われ、実際のディスク領域を消費します。ゲスト仮想マシン用のディスクを作成する場合に特に役立ちます。これにより、ディスクに必要なディスク領域よりもはるかに多くのディスク領域が使用されるようになります。たとえば、10Gb のディスクイメージで -S を 50Gb に設定すると、実際には 10Gb しか使用されていなくても、そのディスク領域の 10Gb は 60Gb に見えます。

filename 形式を使用して、ディスクイメージ output_filename をディスクイメージ output_format に変換します。ディスクイメージは、-c オプションで圧縮するか、-o encryption を設定して -o オプションで暗号化できます。-o パラメーターで使用できるオプションは、選択した形式とは異なることに注意してください。

qcow2 形式のみが暗号化または圧縮をサポートします。qcow2 暗号化は、安全な 128 ビット鍵で AES 形式を使用します。qcow2 圧縮は読み取り専用であるため、圧縮したセクターが qcow2 形式から変換されると、非圧縮データとして新しい形式に書き込まれます。

Create

サイズsize、フォーマットformat、新しいディスクイメージの ファイル名を作成します。

# qemu-img create [-fformat] [-o options] filename [size][preallocation]

-o backing_file=filename で指定されている場合は、イメージ自体とベースイメージの違いのみが記録されます。バッキングファイルは、commit コマンドを使用しない限り変更されません。この場合、サイズの指定は必要ありません。

-o preallocation=off|meta|full|falloc が含まれます。事前に割り当てられたメタデータを持つイメージは、イメージよりも大きくなります。ただし、イメージサイズが大きくなると、イメージのサイズが大きくなるとパフォーマンスが向上します。

full 割り当ての使用には、イメージのサイズが大きい場合に時間がかかる可能性があることに注意してください。完全な割り当てと時間が経つ必要がある場合、フラックを使用 falloc 時間を節約できます。

Info

info パラメーターは、ディスクイメージのfilenameに関する情報を表示します。info オプションの形式は、以下のとおりです。

# qemu-img info [-f format] filename

qcow2 イメージが使用している領域を表示します。これは、qemu-img を実行して行います。使用中のイメージが、qemu-img check コマンドで qemu-img info コマンドの出力と一致するイメージであることを確認できます。「qemu-img の使用」 を参照してください。

# qemu-img info /dev/vg-90.100-sluo/lv-90-100-sluo image: /dev/vg-90.100-sluo/lv-90-100-sluo file format: qcow2 virtual size: 20G (21474836480 bytes) disk size: 0 cluster_size: 65536

マップ

# qemu-img map [-f format] [--output=output_format] filename コマンドは、イメージファイル名のメタデータとそのバッキングファイルチェーンをダンプします。具体的には、このコマンドは、指定されたファイルのすべてのセクターの割り当て状態を、それをバッキングファイルチェーンに割り当てる最上位のファイルとともにダンプします。たとえば、c.qcow2 → b.qcow2 → a.qcow2 などのチェーンがある場合、a.qcow2 が元のファイルである場合、b.qcow2 は a.qcow2 に加えられた変更で、c.qcow2 は b.qcow2 のデルタファイルになります。このチェーンが作成されると、イメージファイルは通常のイメージデータを保存し、どのファイルの場所とそれがファイルに保存されるかに関する情報も保存されます。この情報は、イメージのメタデータと呼ばれます。-f フォーマットオプションは、指定されたイメージファイルのフォーマットです。raw、qcow2、vhdx、vmdk などの形式を使用できます。可能な出力オプションには、human と json の 2 つがあります。

humanがデフォルト設定です。人間の目に読みやすくなるように設計されているため、この形式は解析しないでください。明確さと単純さのために、デフォルトのhumanフォーマットは、ファイルの既知のゼロ以外の領域のみをダンプします。ファイルの既知のゼロの部分は完全に省略され、同様にチェーン全体に割り当てられていない部分も省略されます。コマンドが実行されると、qemu-img 出力は、データを読み取ることができるファイルと、ファイル内のオフセットを識別します。出力は、4 列のテーブルとして表示されます。最初の 3 つは 16 進数です。# qemu-img map -f qcow2 --output=human /tmp/test.qcow2 Offset Length Mapped to File 0 0x20000 0x50000 /tmp/test.qcow2 0x100000 0x80000 0x70000 /tmp/test.qcow2 0x200000 0x1f0000 0xf0000 /tmp/test.qcow2 0x3c00000 0x20000 0x2e0000 /tmp/test.qcow2 0x3fd0000 0x10000 0x300000 /tmp/test.qcow2

json、つまり JSON (JavaScript Object Notation) は、人間が読むこともできますが、プログラミング言語であるため、解析することも前提に設計されています。たとえば、パーサーで qemu-img map の出力を解析する場合は、オプション--output=jsonを使用する必要があります。# qemu-img map -f qcow2 --output=json /tmp/test.qcow2 [{ "start": 0, "length": 131072, "depth": 0, "zero": false, "data": true, "offset": 327680}, { "start": 131072, "length": 917504, "depth": 0, "zero": true, "data": false},JSON 形式の詳細については、qemu-img (1) の man ページを参照してください。

リベース

イメージのバッキングファイルを変更します。

# qemu-img rebase [-f format] [-t cache] [-p] [-u] -b backing_file [-F backing_format] filename

qcow2 形式のみです。

サイズの変更

サイズ sizeで作成されたかのように、ディスクイメージのfilenameを変更します。バージョンに関係なく、サイズ変更できるのは raw 形式のイメージのみです。Red Hat Enterprise Linux 6.1 以降では、qcow2 フォーマットでイメージを拡大 (縮小はしない) する機能が追加されています。

# qemu-img resize filename size

+ を付けて拡大するか、- を付けてディスクイメージのサイズをそのバイト数だけ縮小します。ユニットの接尾辞を追加すると、イメージのサイズをキロバイト (K)、メガバイト (M)、ギガバイト (G)、またはテラバイト (T) で設定できます。

# qemu-img resize filename [+|-]size[K|M|G|T]

スナップショット

イメージ (ファイル名) の既存のスナップショット (スナップショット) を一覧表示、適用、作成、または削除します。

# qemu-img snapshot [ -l | -a snapshot | -c snapshot | -d snapshot ] filename

サポート対象の形式

qemu-img は、ファイルを次のいずれかのフォーマットに変換するように設計されています。

-

raw - Raw ディスクイメージ形式 (デフォルト)これは、ファイルベースで最も高速な形式になります。ファイルシステムがホールをサポートしている場合 (たとえば、Linux の ext2 または ext3、Windows の NTFS)、書き込まれたセクターのみがスペースを予約します。qemu-img info を使用して、イメージが使用する実際のサイズを取得するか、Unix/Linux の ls -ls を取得します。Raw イメージは最適なパフォーマンスを提供しますが、Raw イメージで使用できるのは非常に基本的な機能のみです (たとえば、スナップショットは使用できません)。

-

qcow2 - QEMU イメージ形式。最も汎用性が高く、機能セットが最適な形式です。これを使用して、オプションの AES 暗号化、zlib ベースの圧縮、複数の VM スナップショットのサポート、およびホールをサポートしないファイルシステム (Windows 上の非 NTFS ファイルシステム) で役立つ小さなイメージを使用します。この拡張機能セットはパフォーマンスに影響を与えることに注意してください。

raw、または qcow2 形式に変換するために、以下の形式も認識してサポートします。イメージの形式は、通常、自動的に検出されます。この形式を raw または qcow2 に変換することに加えて、raw または qcow2 から元の形式に戻すことができます。

- bochs

- Bochs ディスクイメージ形式。

- cloop

- Linux Compressed Loop イメージ。Knoppix CD-ROM などにある直接圧縮 CD-ROM イメージを再利用する場合にのみ役立ちます。

- cow

- User Mode Linux Copy On Write イメージ形式。cow 形式は、以前のバージョンとの互換性のためにのみ同梱されています。Windows では動作しません。

- dmg

- Mac ディスクイメージフォーマット。

- nbd

- ネットワークブロックデバイス。

- parallels

- Parallels 仮想化ディスクイメージフォーマット。

- qcow

- 古い QEMU イメージフォーマット。古いバージョンとの互換性にのみ含まれます。

- vdi

- Oracle VM VirtualBox ハードディスクイメージ形式。

- vmdk

- VMware 互換のイメージフォーマット (バージョン 1 および 2 の読み取り/書き込みサポート、およびバージョン 3 の読み取り専用サポート)。

- vpc

- WindowsVirtualPC のディスクイメージフォーマット。

vhd、または Microsoft 仮想ハードディスクイメージフォーマットとも呼ばれます。 - vvfat

- 仮想 VFAT ディスクイメージフォーマット。

10.2. QEMU ゲストエージェント

10.2.1. ゲストエージェントをインストールして有効にする

10.2.2. ゲストエージェントとホスト間の通信の設定

手順10.1 ゲストエージェントとホスト間の通信の設定

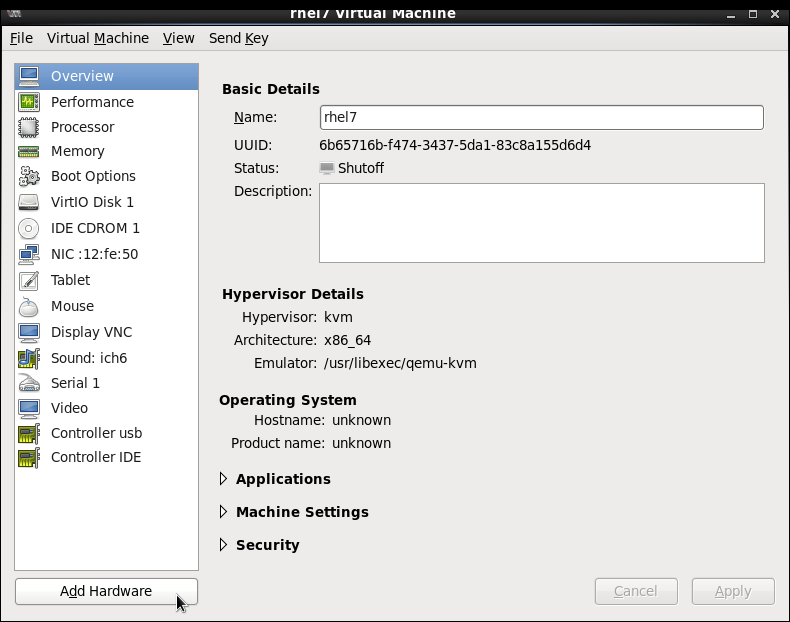

ゲスト XML を開きます

QEMU ゲストエージェント設定でゲスト XML を開きます。ファイルを開くにはゲスト名が必要です。ホストマシンでコマンド #virsh list を使用して、認識できるゲストを一覧表示します。この例では、ゲストの名前は rhel6 です。# virsh edit rhel6ゲスト XML ファイルを編集します

次の要素を XML ファイルに追加し、変更を保存します。図10.1 ゲスト XML を編集して QEMU ゲストエージェントを設定する

<channel type='unix'> <source mode='bind' path='/var/lib/libvirt/qemu/rhel6.agent'/> <target type='virtio' name='org.qemu.guest_agent.0'/> </channel>

ゲストでの QEMU ゲストエージェントの起動

まだ行っていない場合は、yum install qemu-guest-agent を使用してゲスト仮想マシンにゲストエージェントをダウンロードしてインストールします。インストールしたら、次のようにサービスを開始します。# service start qemu-guest-agent

10.2.3. QEMU ゲストエージェントの使用

- qemu-guest-agentは、クライアントがチャネルに接続したかどうかを検出することはできません。

- クライアントが、qemu-guest-agent がバックエンドに切断または再接続したかどうかを検出する方法はありません。

- virtio-serial デバイスがリセットされ、qemu-guest-agentチャネルに接続されていない場合 (通常、再起動またはホットプラグが原因)、クライアントからのデータはドロップされます。

- virtio-serial デバイスのリセット後に qemu-guest-agent がチャネルに接続した場合、qemu-guest-agent がまだ実行中か接続中かにかかわらず、クライアントからのデータはキューに入れられます (そして利用可能なバッファーを使い切ると最終的にスロットルに入れられます)。

10.2.4. libvirt での QEMU ゲストエージェントの使用

- virsh shutdown --mode=agent - このシャットダウン方法は、virsh shutdown --mode=acpi よりも信頼性が高くなります。QEMU ゲストエージェントで使用する virsh shutdown は、クリーンな状態で協調ゲストをシャットダウンすることが保証されます。エージェントが存在しない場合、libvirt は代わりに ACPI シャットダウンイベントの挿入に依存する必要がありますが、一部のゲストはそのイベントを無視するため、シャットダウンしません。virsh reboot と同じ構文で使用できます。

- virsh snapshot-create --quiesce - スナップショットが作成される前に、ゲストが I / O を安定した状態にフラッシュできるようにします。これにより、fsck を実行したり、データベーストランザクションの一部を失うことなくスナップショットを使用できます。ゲストエージェントは、ゲストの相互作用を提供することで、高レベルのディスクコンテンツの安定性を実現します。

- virsh setvcpus --guest - CPU をオフラインにするようにゲストに指示します。

- virsh dompmsuspend - ゲストオペレーティングシステムの電源管理機能を使用して、実行中のゲストを優雅に一時停止します。

10.2.5. ゲスト仮想マシンのディスクバックアップの作成

- ファイルシステムアプリケーション/データベースは、作業バッファーを仮想ディスクにフラッシュし、クライアント接続の受け入れを停止します。

- アプリケーションがデータファイルを一貫した状態にします。

- メインフックスクリプトが返されます。

- qemu-ga ファイルシステムをフリーズし、管理スタックがスナップショットを取得します

- スナップショットが確認されました。

- ファイルシステムの機能が再開します。

/etc/qemu-ga/fsfreeze-hook.d/ というラベルが付いた表の行の 表10.1「QEMU ゲストエージェントパッケージの内容」 に一覧表示されている restorecon -FvvR コマンドを実行した後、ファイルシステムノードへのアクセスがすぐに機能するようになります。

表10.1 QEMU ゲストエージェントパッケージの内容

| File name | 説明 |

|---|---|

/etc/rc.d/init.d/qemu-ga | QEMU ゲストエージェントのサービス制御スクリプト (start/stop) |

/etc/sysconfig/qemu-ga | /etc/rc.d/init.d/qemu-ga 制御スクリプトによって読み取られる QEMU ゲストエージェントの設定ファイル。設定は、シェルスクリプトのコメントが記載されたファイルで説明されています。 |

/usr/bin/qemu-ga | QEMU ゲストエージェントのバイナリーファイル。 |

/usr/libexec/qemu-ga/ | フックスクリプトのルートディレクトリー。 |

/usr/libexec/qemu-ga/fsfreeze-hook | メインフックスクリプト。ここでは変更は必要ありません。 |

/usr/libexec/qemu-ga/fsfreeze-hook.d/ | 個々のアプリケーション固有のフックスクリプトのディレクトリー。ゲストシステム管理者は、フックスクリプトを手動でこのディレクトリーにコピーし、適切なファイルモードビットを確認してから、このディレクトリーで restorecon -FvvR を実行する必要があります。 |

/usr/share/qemu-kvm/qemu-ga/ | サンプルスクリプトを含むディレクトリー (サンプル目的のみ)ここに含まれるスクリプトは実行されません。 |

/usr/libexec/qemu-ga/fsfreeze-hook は、独自のメッセージと、アプリケーション固有のスクリプトの標準出力およびエラーメッセージを、ログファイル /var/log/qemu-ga/fsfreeze-hook.log に記録します。詳細は、wiki.qemu.org または libvirt.org にあるqemu-guest-agentwiki ページを参照してください。

10.3. Windows ゲストでの QEMU ゲストエージェントの実行

- Windows XP Service Pack 3 (VSS はサポートされていません)

- Windows Server 2003 R2 - x86 および AMD64 (VSS はサポートされていません)

- Windows Server 2008

- Windows Server 2008 R2

- Windows7 - x86 および AMD64

- Windows Server 2012

- Windows Server 2012 R2

- Windows8 - x86 および AMD64

- Windows8.1 - x86 および AMD64

手順10.2 Windows ゲストでの QEMU ゲストエージェントの設定

Red Hat Enterprise Linux ホストマシンを準備します

次のパッケージが Red Hat Enterprise Linux ホスト物理マシンにインストールされていることを確認してください。- virtio-win

usr/share/virtio-win/にあります。

Windows ゲストのドライバーをコピーするには、次のコマンドを使用して qxl ドライバーの*.isoファイルを作成します。# mkisofs -o /var/lib/libvirt/images/virtiowin.iso /usr/share/virtio-win/driversWindows ゲストを準備する

virtio-serial をインストールしますドライバーを更新するために Windows ゲストに*.isoをマウントすることにより、ゲストのドライバー。ゲストを起動し、次に示すようにドライバーの.iso ファイルをゲストに添付します ( hdb という名前のディスクを使用)。# virsh attach-disk guest /var/lib/libvirt/images/virtiowin.iso hdbWindows の コントロールパネル を使用してドライバーをインストールするには、次のメニューに移動します。- virtio-win ドライバーをインストールするには - ハードウェアとサウンド > デバイスマネージャー > virtio- シリアルドライバー を選択します。

Windows ゲスト XML 設定ファイルを更新します

Windows ゲストのゲスト XML ファイルは、Red Hat Enterprise Linux ホストマシンにあります。このファイルにアクセスするには、Windows ゲスト名が必要です。ホストマシンで #virsh list コマンドを使用して、認識できるゲストを一覧表示します。この例では、ゲストの名前は win7x86 です。#virsh edit win7x86 コマンドを使用して次の要素を XML ファイルに追加し、変更を保存します。ソースソケット名は、この例では win7x86.agent という名前で、ホスト内で一意である必要があることに注意してください。図10.2 Windows ゲスト XML を編集して QEMU ゲストエージェントを設定する

... <channel type='unix'> <source mode='bind' path='/var/lib/libvirt/qemu/win7x86.agent'/> <target type='virtio' name='org.qemu.guest_agent.0'/> <address type='virtio-serial' controller='0' bus='0' port='1'/> </channel> <channel type='spicevmc'> <target type='virtio' name='com.redhat.spice.0'/> <address type='virtio-serial' controller='0' bus='0' port='2'/> </channel> ...Windows ゲストを再起動します

Windows ゲストを再起動して、変更を適用します。# virsh reboot win7x86Windows ゲストで QEMU ゲストエージェントを準備します

Windows ゲストでゲストエージェントを準備するには:最新のものをインストールするvirtio-winパッケージ

Red Hat Enterprise Linux ホストの物理マシンのターミナルウィンドウで次のコマンドを実行して、インストールするファイルを見つけます。以下に示すファイルは、システムが検出したファイルと完全に同じではない場合がありますが、最新の公式バージョンである必要があることに注意してください。# rpm -qa|grep virtio-win virtio-win-1.6.8-5.el6.noarch # rpm -iv virtio-win-1.6.8-5.el6.noarch

インストールが完了したことを確認します

後に virtio-win パッケージのインストールが完了したら、/usr/share/virtio-win/guest-agent/フォルダーを確認すると、次のような qemu-ga-x64.msi または qemu-ga-x86.msi という名前のファイルが見つかります。# ls -l /usr/share/virtio-win/guest-agent/ total 1544 -rw-r--r--. 1 root root 856064 Oct 23 04:58 qemu-ga-x64.msi -rw-r--r--. 1 root root 724992 Oct 23 04:58 qemu-ga-x86.msi

.msi ファイルをインストールします

Windows ゲスト (たとえば、win7x86) から、ファイルをダブルクリックして qemu-ga-x64.msi または qemu-ga-x86.msi をインストールします。インストールされると、システムマネージャー内の Windows ゲストに qemu-ga サービスとして表示されます。この同じマネージャーを使用して、サービスのステータスを監視できます。

10.3.1. Windows ゲストでの QEMUGuestAgent での libvirt コマンドの使用

- virsh shutdown --mode=agent - このシャットダウン方法は、virsh shutdown --mode=acpi よりも信頼性が高くなります。QEMU ゲストエージェントで使用する virsh shutdown は、クリーンな状態で協調ゲストをシャットダウンすることが保証されます。エージェントが存在しない場合、libvirt は代わりに ACPI シャットダウンイベントの挿入に依存する必要がありますが、一部のゲストはそのイベントを無視するため、シャットダウンしません。virsh reboot と同じ構文で使用できます。

- virsh snapshot-create --quiesce - スナップショットが作成される前に、ゲストが I / O を安定した状態にフラッシュできるようにします。これにより、fsck を実行したり、データベーストランザクションの一部を失うことなくスナップショットを使用できます。ゲストエージェントは、ゲストの相互作用を提供することで、高レベルのディスクコンテンツの安定性を実現します。

- virsh dompmsuspend - ゲストオペレーティングシステムの電源管理機能を使用して、実行中のゲストを優雅に一時停止します。

10.4. デバイスリダイレクトの制限の設定

-device usb-redir に渡します。filter プロパティーは、フィルタールールで設定される文字列を取ります。ルールの形式は次のとおりです。

<class>:<vendor>:<product>:<version>:<allow>-1 の値を使用して、特定のフィールドに任意の値を受け入れるように指定します。同じコマンドラインで、| を区切り文字として使用し、複数のルールを使用できます。デバイスがどのフィルタールールにも一致しない場合、リダイレクトは許可されないことに注意してください。

例10.1 Windows ゲスト仮想マシンによるリダイレクトの制限

- Windows 7 ゲスト仮想マシンを準備します。

- 以下のコード抜粋をゲスト仮想マシンの XML ファイルに追加します。

<redirdev bus='usb' type='spicevmc'> <alias name='redir0'/> <address type='usb' bus='0' port='3'/> </redirdev> <redirfilter> <usbdev class='0x08' vendor='0x1234' product='0xBEEF' version='2.0' allow='yes'/> <usbdev class='-1' vendor='-1' product='-1' version='-1' allow='no'/> </redirfilter> - ゲスト仮想マシンを起動し、次のコマンドを実行して設定の変更を確認します。

# ps -ef | grep $guest_name-device usb-redir,chardev=charredir0,id=redir0,/ filter=0x08:0x1234:0xBEEF:0x0200:1|-1:-1:-1:-1:0,bus=usb.0,port=3

- USB デバイスをホストの物理マシンに接続し、virt-viewer を使用してゲスト仮想マシンに接続します。

- メニューで USB デバイスの選択 をクリックすると、一部の USB デバイスはホストポリシーによってブロックされていますというメッセージが表示されます。OK をクリックして確定し、続行します。フィルターが有効になります。

- フィルターが正しくキャプチャーされていることを確認するには、USB デバイスのベンダーと製品を確認してから、USB リダイレクトを可能にするために、ホストの物理マシンのドメイン XML で次の変更を行います。