配置和管理虚拟化

设置您的主机、创建和管理虚拟机并了解 Red Hat Enterprise Linux 8 中的虚拟化功能

摘要

- 虚拟化的功能和用例

- 如何使用命令行工具以及 web 控制台管理您的主机和虚拟机

- 在各种系统构架上虚拟化的支持限制,如 Intel 64、AMD64、IBM POWER 和 IBM Z

对红帽文档提供反馈

我们感谢您对我们文档的反馈。让我们了解如何改进它。

通过 Jira 提交反馈(需要帐户)

- 登录到 Jira 网站。

- 单击顶部导航栏中的 Create。

- 在 Summary 字段中输入描述性标题。

- 在 Description 字段中输入您的建议以改进。包括文档相关部分的链接。

- 点对话框底部的 Create。

第 1 章 介绍 RHEL 中的虚拟化

如果您对虚拟化概念或其在 Linux 中的实施不熟悉,以下小节提供了 RHEL 8 虚拟化的一般概述:红帽提供的基本知识、优势、组件和其他可能的虚拟化解决方案。

1.1. 什么是虚拟化?

RHEL 8 提供虚拟化功能,它让运行 RHEL 8 的机器能够托管(host) 多个虚拟机(VM),也称为客户机(guest)。VM 使用主机的物理硬件和计算资源,在主机操作系统中作为用户空间进程运行一个独立的虚拟操作系统(客户机操作系统)。

换句话说,虚拟化功能使在一个操作系统中执行其他操作系统成为可能。

VM 可让您安全地测试软件配置和功能,运行旧的软件或优化硬件的工作负载效率。有关优点的更多信息,请参阅 虚拟化的优势。

有关什么是虚拟化的更多信息,请参阅 虚拟化主题页面。

后续步骤

- 要在 Red Hat Enterprise Linux 8 中尝试虚拟化,请参阅开始使用虚拟化。

- 除了 Red Hat Enterprise Linux 8 虚拟化外,红帽还提供了多种专用的虚拟化解决方案,每种解决方案都有不同的用户重点和特性。如需更多信息,请参阅 Red Hat 虚拟化解决方案。

1.2. 虚拟化的优点

与使用物理机器相比,使用虚拟机(VM)有以下优点:

灵活精细的资源分配

一个虚拟机在主机机器(通常是物理机器)上运行,主机的硬件也可以分配给客户机操作系统使用。但是,物理资源分配是在软件级别上完成的,因此非常灵活。虚拟机使用的主机内存、CPU 或存储空间的比例是可以配置的,可以指定非常精细的资源请求。

例如:客户机操作系统的磁盘可以在主机的文件系统中以一个文件代表,且该磁盘的大小限制比物理磁盘的限制要小。

软件控制的配置

虚拟机的整个配置都作为数据保存在主机上,并由软件控制。因此,虚拟机可轻松创建、删除、克隆、迁移、远程操作或连接到远程存储。

与主机分离

在虚拟内核中运行的客户机操作系统与主机操作系统分开。这意味着可在虚拟机中安装任何操作系统,即使虚拟机操作系统不稳定或受损,主机也不会受到任何影响。

空间及成本效率

单个物理机器可以托管大量虚拟机。因此,无需多个物理机器执行同样的任务,因此降低了与物理硬件关联的空间、电源和维护的要求。

软件兼容性

因为虚拟机可以使用不同于其主机的操作系统,所以通过虚拟化,可以运行最初没有为主机操作系统发布的应用程序。例如,使用 RHEL 7 客户机操作系统,您可以在 RHEL 8 主机系统上运行为 RHEL 7 发布的应用程序。

注意不是所有操作系统都可以作为 RHEL 8 主机中的客户机操作系统被支持。详情请查看 RHEL 8 虚拟化中推荐的功能。

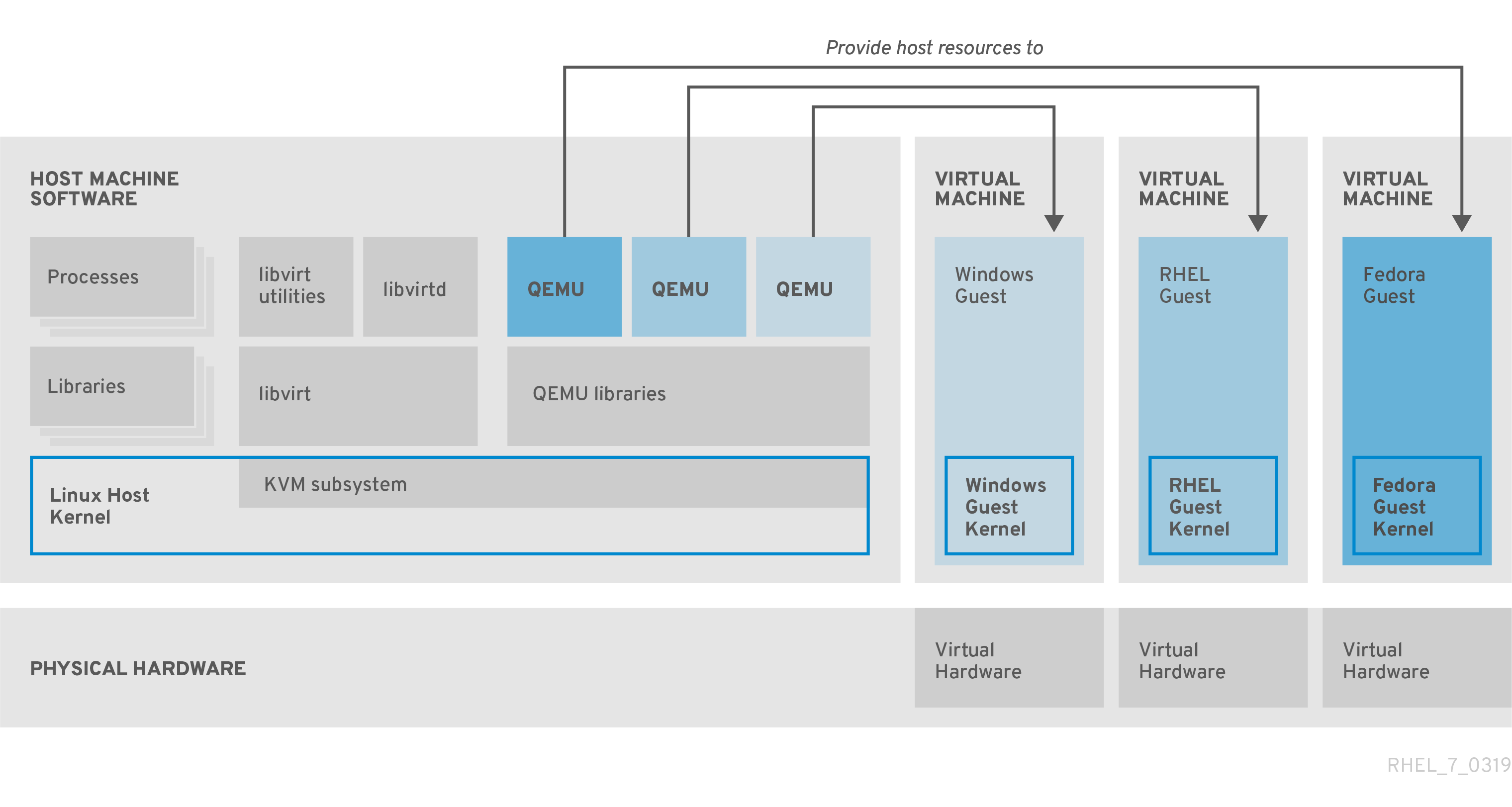

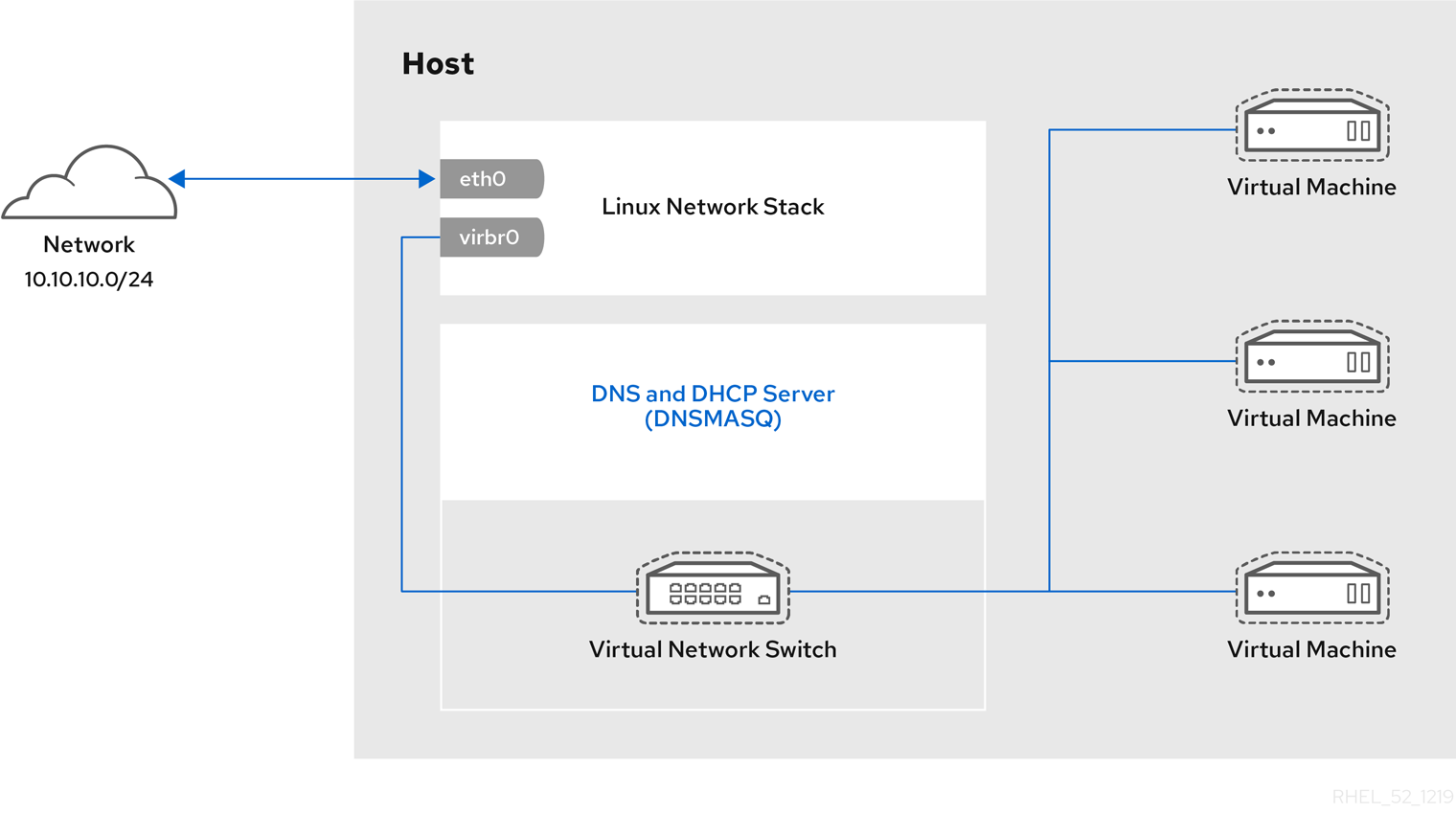

1.3. 虚拟机组件及其交互

RHEL 8 中的虚拟化由以下主要软件组件组成:

虚拟机监控程序(Hypervisor)

在 RHEL 8 中创建虚拟机(VM)的基础是(hypervisor(虚拟机监控程序) ),它是一个软件层用来控制硬件并在主机中运行多个操作系统。

虚拟机监控程序包括 基于内核的虚拟机(KVM) 模块和虚拟化内核驱动程序。这些组件可确保主机中的 Linux 内核为用户空间软件提供虚拟化资源。

在用户空间级别,QEMU 模拟器会模拟一个客户机操作系统可以在上面运行的完整虚拟硬件平台,并管理如何在主机中分配资源并提供给客户机。

此外,libvirt 软件套件充当管理和通信层,使 与 QEMU 更容易交互、实施安全规则,并提供用于配置和运行 VM 的许多其他工具。

XML 配置

基于主机的 XML 配置文件(也称域 XML 文件)决定了特定虚拟机中的所有设置和设备。配置包括:

- 元数据,如虚拟机名称、时区和其他有关虚拟机的信息。

- 对虚拟机中的设备的描述,包括虚拟 CPU(vCPUS)、存储设备、输入/输出设备、网络接口卡及其他真实和虚拟硬件。

- 虚拟机设置,如它可以使用的最大内存量、重启设置和其他有关虚拟机行为的设置。

有关 XML 配置内容的更多信息,请参阅 虚拟机 XML 配置示例。

组件交互

当虚拟机启动时,虚拟机监控程序使用 XML 配置在主机上以用户空间进程的形式创建虚拟机实例。hypervisor 还使虚拟机进程能被基于主机的接口访问,如 virsh、virt-install 和 guestfish 工具,或者 Web 控制台 GUI。

当使用这些虚拟化工具时,libvirt 会将它们的输入转换成 QEMU 的指令。QEMU 将指令信息发送到 KVM,这样可确保内核正确分配执行该指令所需的资源。因此,QEMU 可以执行相应的用户空间更改,如创建或修改虚拟机或在虚拟机的客户机操作系统中执行操作。

尽管 QEMU 是构架中的基本组件,但出于安全考虑,它并没有被设计为直接在 RHEL 8 系统中使用。因此,红帽不支持 qemu USBGuard 命令,强烈建议您使用 libvirt 与 QEMU 交互。

有关基于主机的接口的更多信息,请参阅 虚拟化管理的工具和接口。

图 1.1. RHEL 8 虚拟化架构

1.4. 用于虚拟化管理的工具和界面

您可以使用命令行界面(CLI)或几个图形用户界面(GUI)管理 RHEL 8 中的虚拟化。

命令行界面

CLI 是在 RHEL 8 中管理虚拟化的最强大的方法。虚拟机(VM)管理的 CLI 命令包括:

virsh - 一个多用途的虚拟化命令行工具程序和 shell,根据提供的参数,可以实现不同功能。例如:

-

启动和关闭虚拟机 -

virsh start和virsh shutdown -

列出可用的虚拟机 -

virsh list -

从配置文件创建虚拟机 -

virsh create -

进入虚拟化 shell -

virsh

如需更多信息,请参阅系统中的

virsh (1)手册页。-

启动和关闭虚拟机 -

-

virt-install- 用于创建新虚拟机的 CLI 工具。如需更多信息,请参阅系统中的virt-install (1)手册页。 -

virt-xml- 用于编辑虚拟机配置的工具。 -

guestfish- 用于检查和修改虚拟机磁盘镜像的工具。如需更多信息,请参阅系统中的guestfish (1)手册页。

图形界面

您可以使用以下 GUI 在 RHEL 8 中管理虚拟化:

RHEL 8 web 控制台 (也称为 Cockpit )提供了一个远程的、易于使用的图形用户界面管理虚拟机和虚拟化主机。

有关使用 web 控制台进行基本虚拟化管理的步骤,请参阅 web 控制台中管理虚拟机。

虚拟机管理器(virt-manager)应用程序提供管理虚拟机和虚拟化主机的专用 GUI。

重要虽然 RHEL 8 中仍在支持,但 virt-manager 已被弃用。在以后的版本中计划使用 Web 控制台替换它。因此,建议您熟悉通过 web 控制台使用 GUI 管理虚拟化。

但是,在 RHEL 8 中,某些功能只能从 virt-manager 或命令行访问。详情请参阅 虚拟机管理器和 web 控制台中虚拟化功能之间的差别。

Gnome Boxes 应用程序是一个轻量级图形界面,可用来查看和访问虚拟机和远程系统。GNOME Boxes 主要用于桌面系统。

重要GNOME Boxes 作为 GNOME 桌面环境的一部分提供,在 RHEL 8 中被支持,但红帽建议您通过 web 控制台使用 GUI 管理虚拟化。

其它资源

1.5. 红帽虚拟化解决方案

以下红帽产品基于 RHEL 8 虚拟化功能构建,并扩展了 RHEL 8 中的 KVM 虚拟化功能。另外,许多 RHEL 8 虚拟化的限制 不适用于这些产品:

- OpenShift Virtualization

OpenShift Virtualization 基于 KubeVirt 技术,作为 Red Hat OpenShift Container Platform 的一部分,并可在容器中运行虚拟机。

有关 OpenShift Virtualization 的更多信息,请参阅红帽混合云页面。

- Red Hat OpenStack Platform(RHOSP)

Red Hat OpenStack Platform 为创建、部署并扩展一个安全可靠的公共或私有 OpenStack 云环境提供了一个集成的基础。

如需有关 Red Hat OpenStack Platform 的更多信息,请参阅红帽客户门户网站或 Red Hat OpenStack Platform 文档套件。

有关 RHEL 中不支持,但在其他 Red Hat 虚拟化解决方案中支持的虚拟化功能,请参阅:RHEL 8 虚拟化中不支持的功能

第 2 章 虚拟化入门

要开始使用RHEL 8 中的虚拟化,请按照以下步骤操作。这样做的默认方法是使用命令行界面(CLI),但为了方便用户,一些步骤可以在 Web 控制台 GUI 中完成。

- 启用虚拟化模块并安装虚拟化软件包 - 请参阅启用虚拟化。

创建虚拟机:

- 对于 CLI,请参阅 使用命令行界面创建虚拟机。

- 对于 GUI,请参阅使用 web 控制台创建虚拟机并安装客户机操作系统。

启动虚拟机:

- 对于 CLI ,请参阅使用命令行界面启动虚拟机。

- 对于 GUI,请参阅使用 web 控制台启动虚拟机。

连接到虚拟机:

- 对于 CLI ,请参阅使用 SSH 连接到虚拟机,或使用 Virt Viewer 打开虚拟机图形控制台。

- 对于 GUI,请参阅使用 web 控制台与虚拟机交互。

Web 控制台目前仅提供一部分虚拟机管理功能,因此对于 RHEL 8 中虚拟化的高级使用,建议使用命令行。

2.1. 启用虚拟化

要在 RHEL 8 中使用虚拟化,您必须启用虚拟化模块,安装虚拟化软件包,并确保您的系统被配置为可托管虚拟机(VM)。

先决条件

- RHEL 8 已安装并在主机上注册。

您的系统满足以下硬件要求以作为虚拟主机工作:

有以下最小系统资源可用:

- 主机有 6 GB 可用磁盘空间,以及每个预期的虚拟机需要额外 6 GB 空间。

- 主机需要 2 GB RAM,以及每个预期的虚拟机需要额外 2 GB。

- 主机上有 4 个 CPU。虚拟机通常可以使用单个分配的 vCPU 运行,但红帽建议为每个虚拟机分配 2 个或更多 vCPU,以避免虚拟机在高负载期间变得无响应。

主机的构架 支持 KVM 虚拟化。

- 值得注意的是,RHEL 8 不支持 64 位 ARM 架构(ARM 64)上的虚拟化。

以下流程适用于 AMD64 和 Intel 64 架构(x86_64)。要在具有不同的受支持构架的主机上启用虚拟化,请参阅以下部分之一:

流程

在 RHEL 8 虚拟化模块中安装软件包:

# yum module install virt安装

virt-install和virt-viewer软件包:# yum install virt-install virt-viewer启动

libvirtd服务:# systemctl start libvirtd

验证

确认您的系统已准备好成为虚拟化主机:

# virt-host-validate [...] QEMU: Checking for device assignment IOMMU support : PASS QEMU: Checking if IOMMU is enabled by kernel : WARN (IOMMU appears to be disabled in kernel. Add intel_iommu=on to kernel cmdline arguments) LXC: Checking for Linux >= 2.6.26 : PASS [...] LXC: Checking for cgroup 'blkio' controller mount-point : PASS LXC: Checking if device /sys/fs/fuse/connections exists : FAIL (Load the 'fuse' module to enable /proc/ overrides)查看

virt-host-validate检查的返回值,并采取适当的措施:-

如果所有

virt-host-validate检查都返回PASS值,则代表您的系统已准备好 创建虚拟机。 -

如果有任何检查返回

FAIL值,请按照显示的说明来修复问题。 -

如果任何检查都返回

WARN值,请考虑按照显示的说明改进虚拟化功能

-

如果所有

故障排除

如果您的主机 CPU 不支持 KVM 虚拟化,

virt-host-validate会生成以下输出:QEMU: Checking for hardware virtualization: FAIL (Only emulated CPUs are available, performance will be significantly limited)

但是,在这样的主机系统上的虚拟机将无法引导,而不存在性能问题。

要临时解决这个问题,您可以将虚拟机的 XML 配置中的

<domain type>的值改为qemu。但请注意,红帽不支持使用qemu域类型的虚拟机,在生产环境中不建议这样做。

2.2. 创建虚拟机

要在 RHEL 8 中创建虚拟机(VM),请使用 命令行界面 或 RHEL 8 web 控制台。

2.2.1. 使用命令行界面创建虚拟机

要使用 virt-install 工具在 RHEL 8 主机上创建虚拟机(VM),请按照以下步骤操作。

先决条件

- 虚拟化已在您的主机系统中启用。

- 您有足够的系统资源来分配给虚拟机,如磁盘空间、RAM 或 CPU。根据虚拟机的预期任务和工作负载,推荐的值可能会有很大不同。

操作系统(OS)安装源可存在于本地或者网络中。可以是以下之一:

- 安装介质的 ISO 镜像

现有虚拟机安装的磁盘镜像

警告在 RHEL 8 中无法从主机 CD-ROM 或者 DVD-ROM 设备安装。当使用 RHEL 8 中的任何虚拟机安装方法时,如果选择了 CD-ROM 或者 DVD-ROM 作为安装源,则安装将失败。如需更多信息,请参阅红帽知识库。

另请注意,红帽只对 一组有限的客户机操作系统 提供支持。

- 可选:对于快速、简单的配置安装,可以使用 Kickstart 文件。

流程

要创建虚拟机并启动其操作系统安装,请使用 virt-install 命令以及以下强制参数:

-

--name: 新机器的名称 -

--memory:分配的内存量 -

--vCPUs :分配的虚拟 CPU 数量 -

--disk:分配的存储的类型和大小 -

--cdrom或--location:操作系统安装源的类型和位置

根据所选安装方法,所需选项和值可能会有所不同。有关示例,请参阅以下命令:

列出的命令使用 VNC 远程显示协议,而不是默认的 SPICE 协议。VNC 目前没有 SPICE 的一些功能,但在 RHEL 9 中被完全支持。因此,如果您将主机迁移到 RHEL 9,使用 VNC 的虚拟机将无法停止工作。如需更多信息,请参阅使用 RHEL 9 的注意事项。

以下命令创建一个名为 demo-guest1 的虚拟机,它从本地存储在 /home/username/Downloads/Win10install.iso 文件中的 ISO 镜像安装 Windows 10 OS。此虚拟机还可分配 2048 MiB RAM 和 2 个 vCPU,为虚拟机自动配置 80 GiB qcow2 虚拟磁盘。

# virt-install \ --graphics vnc \ --name demo-guest1 --memory 2048 \ --vcpus 2 --disk size=80 --os-variant win10 \ --cdrom /home/username/Downloads/Win10install.iso

以下命令创建一个名为 demo-guest2 的虚拟机,它使用 /home/username/Downloads/rhel8.iso 镜像从 live CD 运行 RHEL 8 OS。没有为这个虚拟机分配磁盘空间,因此在此会话中所做的更改不会被保留。另外,虚拟机被分配 4096 MiB RAM 和 4 个 vCPU。

# virt-install \ --graphics vnc \ --name demo-guest2 --memory 4096 --vcpus 4 \ --disk none --livecd --os-variant rhel8.0 \ --cdrom /home/username/Downloads/rhel8.iso

以下命令创建一个名为 demo-guest3 的 RHEL 8 虚拟机,它连接到现有磁盘镜像 /home/username/backup/disk.qcow2。这和在不同的机器间物理地移动硬盘驱动器类似,因此 demo-guest3 可用的操作系统和数据由之前处理镜像的方式决定。另外,这个虚拟机还会分配 2048 MiB RAM 和 2 个 vCPU。

# virt-install \ --graphics vnc \ --name demo-guest3 --memory 2048 --vcpus 2 \ --os-variant rhel8.0 --import \ --disk /home/username/backup/disk.qcow2

请注意,在导入磁盘镜像时,强烈建议使用

--os-variant选项。如果没有提供,创建虚拟机的性能将会受到负面影响。以下命令创建一个名为 demo-guest4 的虚拟机,它从

http://example.com/OS-installURL 安装。要使安装成功启动,URL 必须包含可正常工作的操作系统安装树。另外,操作系统使用 /home/username/ks.cfg kickstart 文件自动配置。此虚拟机还可分配 2048 MiB RAM、2 个 vCPU 和 160 GiB qcow2 虚拟磁盘。# virt-install \ --graphics vnc \ --name demo-guest4 --memory 2048 --vcpus 2 --disk size=160 \ --os-variant rhel8.0 --location http://example.com/OS-install \ --initrd-inject /home/username/ks.cfg --extra-args="inst.ks=file:/ks.cfg console=tty0 console=ttyS0,115200n8"

以下命令创建一个名为 demo-guest5 的虚拟机,它以纯文本模式从

RHEL8.iso镜像文件安装,而无需图形。它将客户端控制台连接到串行控制台。虚拟机有 16384 MiB 内存、16 个 vCPU 和 280 GiB 磁盘。当通过慢速网络连接连接到主机时这种安装很有用。# virt-install \ --name demo-guest5 --memory 16384 --vcpus 16 --disk size=280 \ --os-variant rhel8.0 --location RHEL8.iso \ --graphics none --extra-args='console=ttyS0'

以下命令创建一个名为 demo-guest6 的虚拟机,其配置与 demo-guest5 相同,但位于 192.0.2.1 远程主机上。

# virt-install \ --connect qemu+ssh://root@192.0.2.1/system --name demo-guest6 --memory 16384 \ --vcpus 16 --disk size=280 --os-variant rhel8.0 --location RHEL8.iso \ --graphics none --extra-args='console=ttyS0'

验证

- 如果成功创建虚拟机,则使用虚拟机的图形控制台打开 virt-viewer 窗口并启动客户端操作系统安装。

故障排除

如果

virt-install失败,且出现cannot find default network错误:确定

libvirt-daemon-config-network软件包已安装:# {PackageManagerCommand} info libvirt-daemon-config-network Installed Packages Name : libvirt-daemon-config-network [...]验证

libvirt默认网络是否处于活动状态,并且已配置为自动启动:# virsh net-list --all Name State Autostart Persistent -------------------------------------------- default active yes yes如果没有,激活默认网络并将其设置为 auto-start:

# virsh net-autostart default Network default marked as autostarted # virsh net-start default Network default started

如果激活默认网络失败并显示以下错误,则代表还没有正确安装

libvirt-daemon-config-network软件包。error: failed to get network 'default' error: Network not found: no network with matching name 'default'

要解决这个问题,请重新安装

libvirt-daemon-config-network:# {PackageManagerCommand} reinstall libvirt-daemon-config-network如果激活默认网络失败并显示类似如下的错误,则默认网络子网和主机上现有接口之间出现了冲突。

error: Failed to start network default error: internal error: Network is already in use by interface ens2

要解决这个问题,请使用

virsh net-edit default命令,并将配置中的192.0.2.*值改为主机上尚未使用的子网。

其它资源

-

您系统上的

virt-install (1)手册页 - 使用 web 控制台创建虚拟机并安装客户端操作系统

- 克隆虚拟机

2.2.2. 使用 web 控制台创建虚拟机并安装客户端操作系统

要在 RHEL 8 主机上的 GUI 中管理虚拟机(VM),请使用 web 控制台。以下小节介绍了如何使用 RHEL 8 web 控制台创建虚拟机,并在其上安装客户机操作系统。

使用 Web 控制台创建的虚拟机当前默认使用 SPICE 远程桌面协议。但是,RHEL 9 不支持 SPICE,因此如果您将主机升级到 RHEL 9,则虚拟机将停止工作。如需更多信息,请参阅使用 RHEL 9 的注意事项。

要创建使用 VNC 协议的虚拟机,该协议将在 RHEL 9 上正常工作 ,请使用 命令行界面。

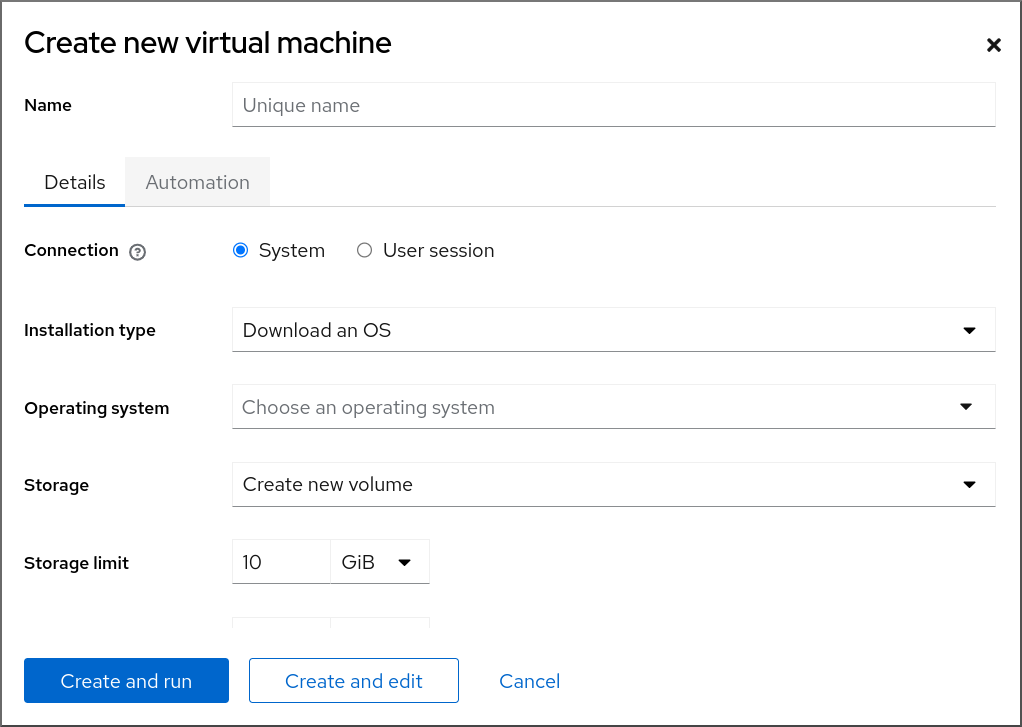

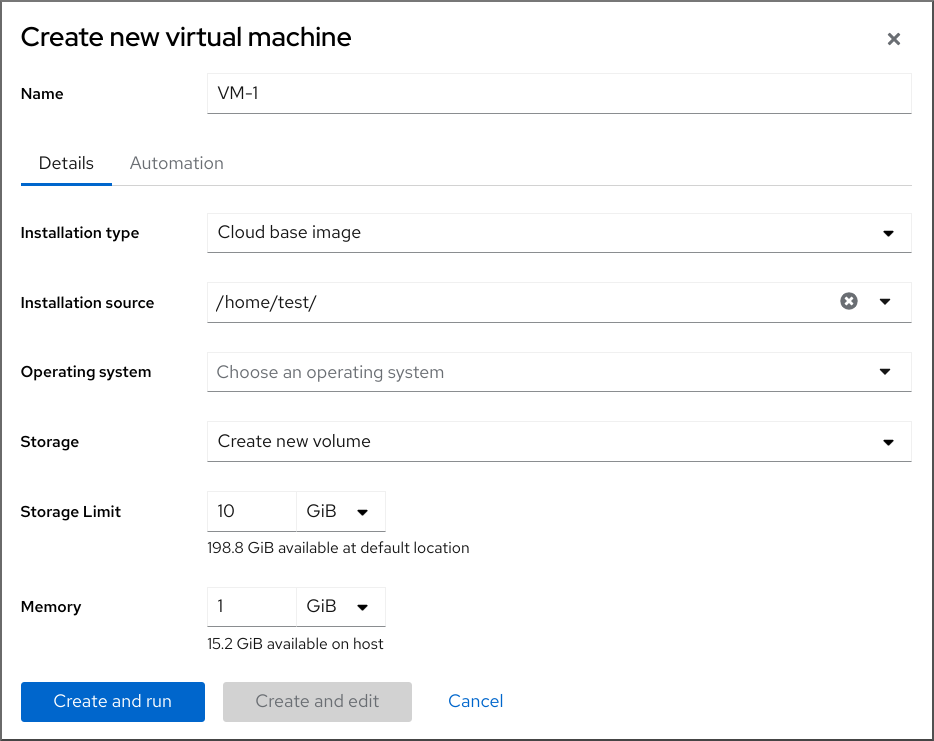

2.2.2.1. 使用 web 控制台创建虚拟机

要在 RHEL 8 web 控制台连接的主机机器上创建一个虚拟机(VM),请使用以下说明。

先决条件

已安装 RHEL 8 web 控制台。

具体步骤请参阅安装并启用 Web 控制台。

- 虚拟化已在您的主机系统上启用。

- Web 控制台 VM 插件已安装在主机系统上。

- 您有足够的系统资源来分配给虚拟机,如磁盘空间、RAM 或 CPU。根据虚拟机的预期任务和工作负载,推荐的值可能会有很大不同。

流程

在 web 控制台的 Virtual Machines 界面中,点 。

此时会出现 Create new virtual machine 对话框。

输入您要创建的虚拟机的基本配置。

- Name - 虚拟机的名称。

- Connection - 授予会话的权限级别。如需了解更多详细信息,请在 web 控制台中展开相关的对话框。

- Installation type - 安装可以使用本地安装介质、URL、PXE 网络引导、云基础镜像,或者从有限的操作系统集中下载操作系统。

Operating system - 在虚拟机上运行的客户机操作系统。请注意,红帽只对 一组有限的客户机操作系统提供支持。

注意要从 web 控制台直接下载并安装 Red Hat Enterprise Linux,您必须在 Offline token 字段中添加一个离线令牌。

- Storage - 存储的类型。

- Storage Limit - 存储空间量。

- Memory - 内存量。

创建虚拟机:

- 如果您希望虚拟机自动安装操作系统,请点 。

- 如果要在安装操作系统前编辑虚拟机,请点击 。

后续步骤

其它资源

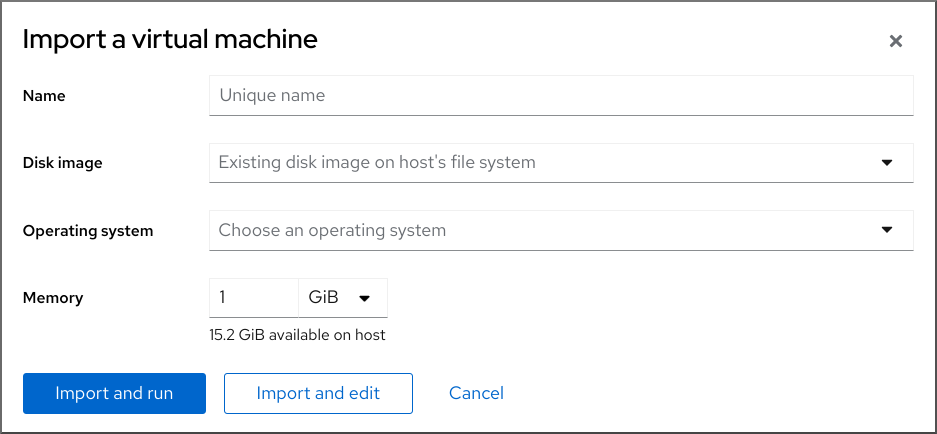

2.2.2.2. 使用 web 控制台导入磁盘镜像来创建虚拟机

您可以通过在 RHEL 8 web 控制台中导入现有虚拟机安装的磁盘镜像来创建一个虚拟机(VM)。

先决条件

已安装 RHEL 8 web 控制台。

具体步骤请参阅安装并启用 Web 控制台。

- Web 控制台 VM 插件已安装在您的系统上。

- 您有足够的系统资源来分配给虚拟机,如磁盘空间、RAM 或 CPU。根据虚拟机的预期任务和工作负载,推荐的值可能会有很大不同。

- 您已下载了现有虚拟机安装的磁盘镜像。

流程

在 web 控制台的 Virtual Machines 界面中,单击 。

此时会出现 Import a virtual machine 对话框。

输入您要创建的虚拟机的基本配置:

- Name - 虚拟机的名称。

- Disk image - 主机系统上虚拟机现有磁盘映像的路径。

- Operating system - 在 VM 磁盘上运行的操作系统。请注意,红帽只对 一组有限的客户机操作系统提供支持。

- Memory - 分配给虚拟机使用的内存量。

导入虚拟机:

- 要在虚拟机上安装操作系统,而无需对虚拟机设置进行额外的编辑,请点 。

- 要在安装操作系统前编辑虚拟机设置,请点 。

2.2.2.3. 使用 Web 控制台安装客户端操作系统

当虚拟机(VM)第一次引导时,您必须在虚拟机上安装操作系统。

如果您在创建新虚拟机时点了 或 ,则操作系统的安装例程会在创建虚拟机时自动启动。

先决条件

已安装 RHEL 8 web 控制台。

具体步骤请参阅安装并启用 Web 控制台。

- Web 控制台 VM 插件已安装在主机系统上。

流程

登录到 RHEL 8 web 控制台。

详情请参阅 登录到 web 控制台。

在 Virtual Machines 界面中,单击要在其上安装客户机操作系统的虚拟机。

此时将打开一个新页面,其中包含有关所选虚拟机的基本信息,以及管理虚拟机各方面的控制。

可选:更改固件。

注意只有在创建新虚拟机时选择了 或 ,且还没有在虚拟机上安装操作系统,您才能更改固件。

- 点击固件。

- 在 Change Firmware 窗口中,选择所需的固件。

- 点 。

点 。

在 VM 控制台中运行的操作系统的安装过程。

故障排除

- 如果安装例程失败,请在再次开始安装前删除并重新创建虚拟机。

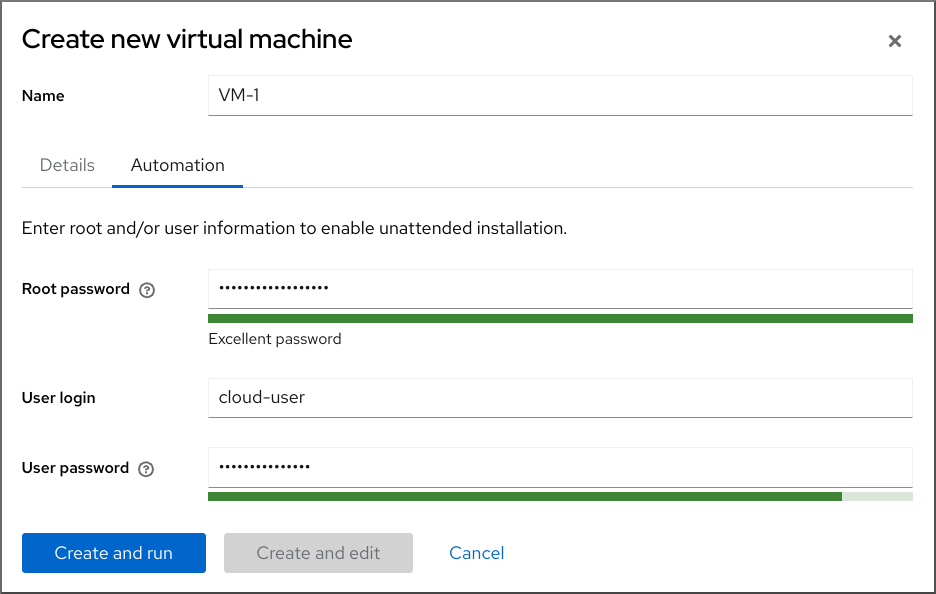

2.2.3. 使用 web 控制台使用云镜像身份验证创建虚拟机

默认情况下,发行版云镜像没有登录帐户。但是,通过使用 RHEL web 控制台,您现在可以创建虚拟机(VM),并指定 root 和用户帐户登录凭证,然后传递给 cloud-init。

先决条件

已安装 RHEL 8 web 控制台。

具体步骤请参阅安装并启用 Web 控制台。

- Web 控制台 VM 插件 已安装在您的系统上。

- 虚拟化已在您的主机系统上 启用。

- 您有足够的系统资源来分配给虚拟机,如磁盘空间、RAM 或 CPU。根据虚拟机的预期任务和工作负载,推荐的值可能会有很大不同。

流程

登录到 RHEL 8 web 控制台。

详情请参阅 登录到 web 控制台。

在 web 控制台的 界面中,点 。

此时会出现 Create new virtual machine 对话框。

- 在 Name 字段中输入虚拟机的名称。

在 Details 标签页中,在 Installation type 字段中选择 Cloud base image。

- 在 Installation source 字段中,设置主机系统上镜像文件的路径。

输入您要创建的虚拟机的配置。

- Operating system - 虚拟机的操作系统.请注意,红帽只对 一组有限的客户机操作系统提供支持。

- Storage - 用于配置虚拟机的存储的类型。

- Storage Limit - 配置虚拟机的存储空间量。

- Memory - 用于配置虚拟机的内存量。

点 Automation 标签页。

设置云身份验证凭证。

- Root password - 输入虚拟机的 root 密码。如果您不想设置 root 密码,请将该字段留空。

- User login - 输入 cloud-init 用户登录名。如果您不想创建用户帐户,请将此字段留空。

User password - 输入密码.如果您不想创建用户帐户,请将此字段留空。

点 。

虚拟机已创建。

其它资源

2.3. 启动虚拟机

要在 RHEL 8 中启动虚拟机(VM),您可以使用 命令行界面 或 web 控制台 GUI。

先决条件

- 在启动虚拟机前,它必须被创建,理想情况下,还要使用操作系统进行安装。有关操作的说明,请参阅 创建虚拟机。

2.3.1. 使用命令行界面启动虚拟机

您可以使用命令行界面(CLI)启动关闭的虚拟机(VM)或恢复保存的虚拟机。通过使用 CLI,您可以启动本地和远程虚拟机。

先决条件

- 已定义的一个不活跃地虚拟机。

- 虚拟机的名称。

对于远程虚拟机:

- 虚拟机所在主机的 IP 地址。

- 对主机的 root 访问权限。

流程

对于本地虚拟机,请使用

virsh start工具。例如,以下命令启动 demo-guest1 虚拟机。

# virsh start demo-guest1 Domain 'demo-guest1' started对于位于远程主机上的虚拟机,请使用

virsh start工具以及与主机的 QEMU+SSH 连接。例如,以下命令在 192.0.2.1 主机上启动 demo-guest1 虚拟机。

# virsh -c qemu+ssh://root@192.0.2.1/system start demo-guest1 root@192.0.2.1's password: Domain 'demo-guest1' started

其它资源

-

virsh start --help命令 - 设置对远程虚拟化主机的简单访问

- 当主机启动时自动启动虚拟机

2.3.2. 使用 web 控制台启动虚拟机

如果虚拟机(VM) 处于关闭状态,您可以使用 RHEL 8 web 控制台启动它。您还可以将虚拟机配置为在主机启动时自动启动。

先决条件

已安装 RHEL 8 web 控制台。

具体步骤请参阅安装并启用 Web 控制台。

- Web 控制台 VM 插件 已安装在您的系统上。

- 已定义的一个不活跃地虚拟机。

- 虚拟机的名称。

流程

在 界面中,点击您要启动的虚拟机。

此时将打开一个新页面,其中包含有关所选虚拟机的详细信息,以及关闭和删除虚拟机的控制。

点 。

虚拟机启动,您可以连接到其控制台或图形输出。

可选: 要将虚拟机配置为在主机启动时自动启动,请切换 Overview 部分中的

Autostart复选框。如果使用不由 libvirt 管理的网络接口,您还必须对 systemd 配置进行额外的更改。否则,受影响的虚拟机可能无法启动,请参阅 当主机启动时自动启动虚拟机。

2.3.3. 当主机启动时自动启动虚拟机

当一个带有运行的虚拟机(VM)的主机重启时,虚拟机将关闭,默认必须手动启动。要确保虚拟机在其主机运行时处于活跃状态,您可以将虚拟机配置为自动启动。

先决条件

流程

使用

virsh autostart工具将虚拟机配置为在主机启动时自动启动。例如,以下命令将 demo-guest1 虚拟机配置为自动启动:

# virsh autostart demo-guest1 Domain 'demo-guest1' marked as autostarted

如果您使用不是由

libvirt管理的网络接口,则也必须对 systemd 配置进行额外的更改。否则,受影响的虚拟机可能无法启动。注意例如,这些接口包括:

-

NetworkManager创建的网桥设备 -

网络配置为使用

<forward mode='bridge'/>

在 systemd 配置目录树中,如果

libvirtd.service.d目录尚不存在,则创建该目录。# mkdir -p /etc/systemd/system/libvirtd.service.d/在之前创建的目录中创建一个

10-network-online.confsystemd 单元覆盖文件。此文件的内容覆盖 libvirtd 服务的默认 systemd 配置。# touch /etc/systemd/system/libvirtd.service.d/10-network-online.conf将以下行添加到

10-network-online.conf文件中:这个配置更改可确保 systemd 仅在主机上的网络就绪后启动libvirtd服务。[Unit] After=network-online.target

-

验证

查看虚拟机配置,并检查是否启用了 autostart 选项。

例如,以下命令显示有关 demo-guest1 虚拟机的基本信息,包括 autostart 选项:

# virsh dominfo demo-guest1 Id: 2 Name: demo-guest1 UUID: e46bc81c-74e2-406e-bd7a-67042bae80d1 OS Type: hvm State: running CPU(s): 2 CPU time: 385.9s Max memory: 4194304 KiB Used memory: 4194304 KiB Persistent: yes Autostart: enable Managed save: no Security model: selinux Security DOI: 0 Security label: system_u:system_r:svirt_t:s0:c873,c919 (enforcing)如果您使用不由 libvirt 管理的网络接口,请检查

10-network-online.conf文件的内容是否与以下输出匹配:$ cat /etc/systemd/system/libvirtd.service.d/10-network-online.conf [Unit] After=network-online.target

其它资源

-

virsh autostart --help命令 - 使用 web 控制台 启动虚拟机。

2.4. 连接至虚拟机

要在 RHEL 8 中与虚拟机(VM)交互,您需要通过以下方法之一连接它:

- 使用 Web 控制台界面时,请在 web 控制台界面中使用 Virtual Machines 窗格。如需更多信息,请参阅使用 web 控制台与虚拟机交互。

- 如果您需要在不使用 Web 控制台的情况下与虚拟机图形显示交互,请使用 Virt Viewer 应用程序。详情请查看使用 Virt Viewer 打开虚拟机图形控制台。

- 如果不需要图形显示,请使用 SSH 终端连接。

- 当使用网络无法从您的系统访问虚拟机时,请使用 virsh 控制台。

如果您要连接的虚拟机位于远程主机而不是本地主机,您可以选择配置您的系统以更方便地访问远程主机。

2.4.1. 使用 web 控制台与虚拟机交互

要在 RHEL 8 web 控制台中与虚拟机(VM)交互,您需要连接到虚拟机的控制台。这包括图形和串行控制台。

- 要在 web 控制台中与虚拟机的图形界面交互,请使用图形控制台。

- 要在远程 viewer 中与虚拟机的图形界面交互,请使用remote viewers 中的图形控制台。

- 要在 web 控制台中与虚拟机的 CLI 交互,请使用 串行控制台。

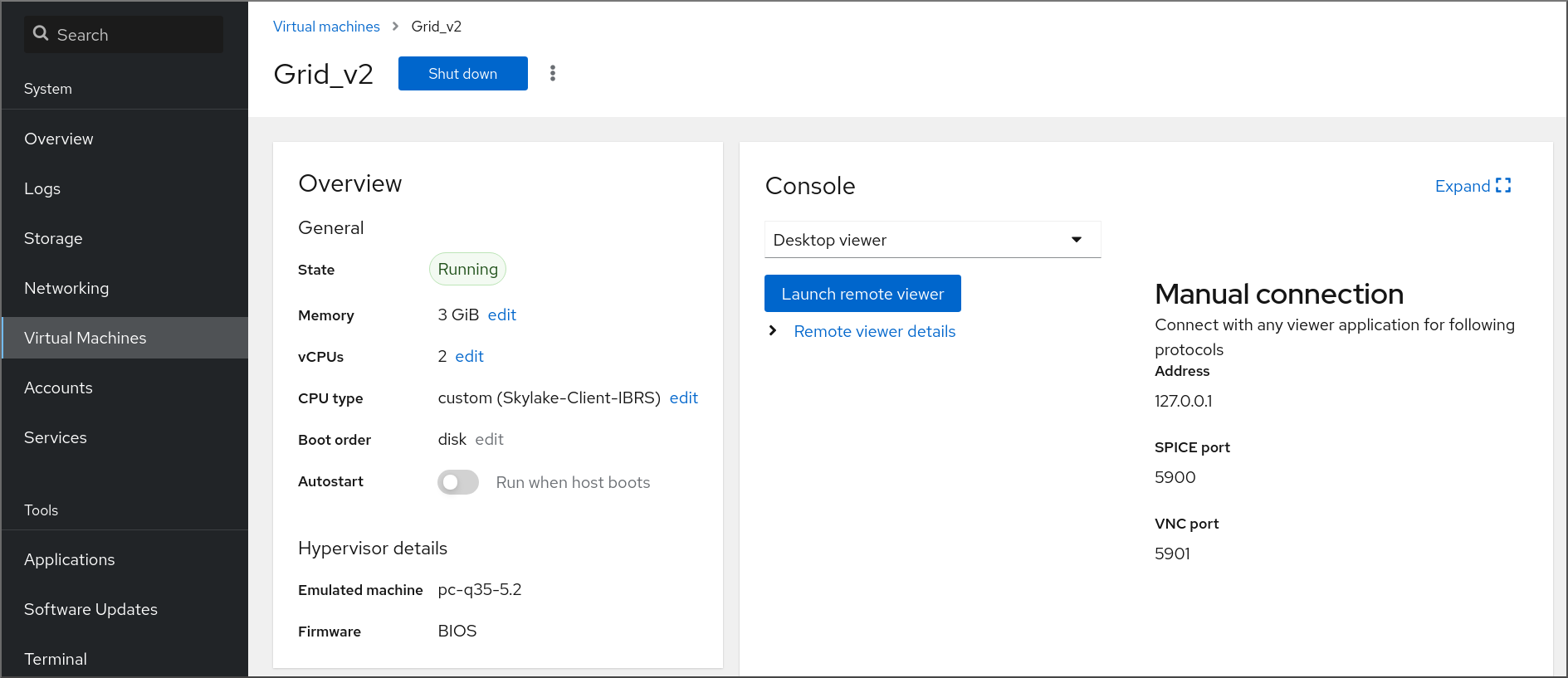

2.4.1.1. 在 web 控制台中查看虚拟机图形控制台

通过使用虚拟机(VM)控制台界面,您可以在 RHEL 8 web 控制台中查看所选虚拟机的图形输出。

先决条件

已安装 RHEL 8 web 控制台。

具体步骤请参阅安装并启用 Web 控制台。

- Web 控制台 VM 插件 已安装在您的系统上。

- 确保主机和虚拟机支持图形界面。

流程

登录到 RHEL 8 web 控制台。

详情请参阅 登录到 web 控制台。

在 界面中,单击您要查看其图形控制台的虚拟机。

此时将打开一个新页面,其中包含虚拟机的 Overview 和 Console 部分。

在控制台下拉菜单中选择 。

VNC 控制台在 Web 界面中的菜单下方显示。

图形控制台会出现在 web 界面中。

单击

现在,您可以使用鼠标和键盘以与实际机器交互的方式与虚拟机控制台交互。VM 控制台中的显示反映了虚拟机上正在执行的操作。

运行 web 控制台的主机可能会截获特定的组合键,如 Ctrl+Alt+Del,阻止它们发送到虚拟机。

要发送此类组合键,请单击 菜单并选择要发送的键序列。

例如,要将 Ctrl+Alt+Del 组合发送给虚拟机,请单击 并选择 菜单条目。

故障排除

- 如果在图形控制台中点击没有任何效果,请将控制台扩展为全屏。这是一个已知的鼠标光标偏移问题。

2.4.1.2. 使用 Web 控制台在远程查看器中查看图形控制台

通过使用 web 控制台界面,您可以在远程查看器(如 Virt Viewer)中显示所选虚拟机(VM)的图形控制台。

您可以在 web 控制台中启动 Virt Viewer。可以手动启动其他 VNC 和 SPICE remote viewer。

先决条件

已安装 RHEL 8 web 控制台。

具体步骤请参阅安装并启用 Web 控制台。

- Web 控制台 VM 插件 已安装在您的系统上。

- 确保主机和虚拟机支持图形界面。

在 Virt Viewer 中查看图形控制台前,您必须在 web 控制台连接的机器上安装 Virt Viewer。

单击 。

virt viewer

.vv、文件下载。- 打开文件以启动 Virt Viewer。

远程查看器在大多数操作系统上提供。但是,一些浏览器扩展和插件不允许 Web 控制台打开 Virt Viewer。

流程

登录到 RHEL 8 web 控制台。

详情请参阅 登录到 web 控制台。

在 界面中,单击您要查看其图形控制台的虚拟机。

此时将打开一个新页面,其中包含虚拟机的 Overview 和 Console 部分。

在控制台下拉菜单中选择 。

点击 。

图形控制台在 Virt Viewer 中打开。

您可以使用鼠标和键盘与虚拟机控制台以与实际机器交互的方式与虚拟机控制台交互。VM 控制台中的显示反映了虚拟机上正在执行的操作。

运行 web 控制台的服务器可以截获特定的组合键,如 Ctrl+Alt+Del,阻止它们发送到虚拟机。

要发送这样的组合键,点 菜单并选择要使用地键序列。

例如:要将 Ctrl+Alt+Del 组合发送到 VM,点 菜单并选择 菜单。

故障排除

- 如果在图形控制台中点击没有任何效果,请将控制台扩展为全屏。这是一个已知的鼠标光标偏移问题。

如果在 web 控制台中启动 Remote Viewer 无法正常工作,或者不佳,您可以使用以下协议手动与任何 viewer 应用程序连接:

-

Address - 默认地址为

127.0.0.1。您可以修改/etc/libvirt/qemu.conf中的vnc_listen或spice_listen参数,以将其更改为主机的 IP 地址。 - SPICE port - 5900

- VNC port - 5901

-

Address - 默认地址为

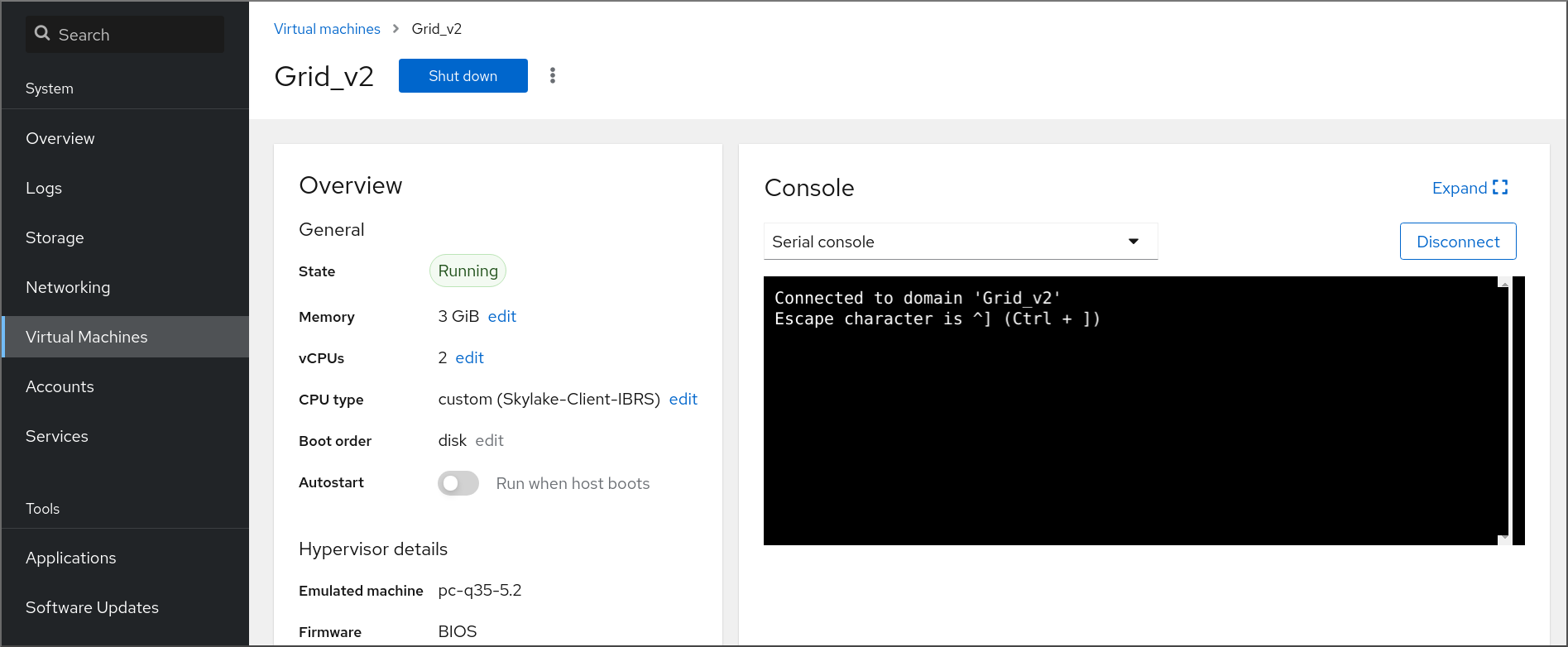

2.4.1.3. 在 web 控制台中查看虚拟机串口控制台

您可以在 RHEL 8 web 控制台中查看所选虚拟机(VM)的串行控制台。这在主机机器或者虚拟机没有使用图形界面配置时很有用。

有关串行控制台的更多信息,请参阅 打开虚拟机串口控制台。

先决条件

已安装 RHEL 8 web 控制台。

具体步骤请参阅安装并启用 Web 控制台。

- Web 控制台 VM 插件 已安装在您的系统上。

流程

登录到 RHEL 8 web 控制台。

详情请参阅 登录到 web 控制台。

在 窗格中,单击您要查看其串行控制台的虚拟机。

此时将打开一个新页面,其中包含虚拟机的 Overview 和 Console 部分。

在控制台下拉菜单中选择 。

图形控制台会出现在 web 界面中。

您可以断开串行控制台与虚拟机的连接和重新连接。

- 要断开串行控制台与虚拟机的连接,请点 。

- 要将串行控制台重新连接到虚拟机,请点 。

2.4.1.4. 在 web 控制台中使用 VNC 替换 SPICE 远程显示协议

SPICE 远程显示协议在 RHEL 8 中已弃用,并将在 RHEL 9 中删除。如果您的虚拟机(VM)配置为使用 SPICE 协议,您可以使用 web 控制台将 SPICE 协议替换为 VNC 协议。但是,某些 SPICE 设备(如音频和 USB 透传)将从虚拟机中删除,因为它们在 VNC 协议中没有合适的替换。

默认情况下,RHEL 8 虚拟机被配置为使用 SPICE 协议。除非从 SPICE 切换到 VNC,否则这些虚拟机无法迁移到 RHEL 9。

先决条件

- Web 控制台 VM 插件 已安装在您的系统上。

- 您有一个配置为使用 SPICE 远程显示协议的现有虚拟机,并且已经关闭。

流程

在 web 控制台的 Virtual Machines 界面中,点配置为使用 SPICE 协议的虚拟机的 Menu 按钮。

此时会打开一个下拉菜单,其中包含各种虚拟机操作的控制。

单击 。

此时会打开 替换 SPICE 设备 对话框。

注意如果您有多个使用 SPICE 协议的现有虚拟机,则会在此对话框中列出它们。在这里,您可以选择在单一步骤中使用 SPICE 转换到 VNC 的虚拟机。

点 。

此时会出现成功操作的确认。

2.4.2. 使用 Virt Viewer 打开虚拟机图形控制台

要连接到 KVM 虚拟机(VM)的图形控制台并在 Virt Viewer 桌面应用程序中打开它,请按照以下流程操作。

先决条件

- 您的系统以及您要连接的虚拟机必须支持图形显示。

- 如果目标虚拟机位于远程主机上,则需要对主机有连接和 root 访问权限。

- 可选: 如果目标虚拟机位于远程主机上,请设置 libvirt 和 SSH 以 更方便地访问远程主机。

流程

要连接到本地虚拟机,请使用以下命令,并将 guest-name 替换为您要连接的虚拟机的名称:

# virt-viewer guest-name要连接到远程虚拟机,请使用

virt-viewer命令及 SSH 协议。例如,以下命令以 root 用户身份连接到远程系统 192.0.2.1 上的名为 guest-name 的虚拟机。连接还需要 192.0.2.1 的 root 身份验证。# virt-viewer --direct --connect qemu+ssh://root@192.0.2.1/system guest-name root@192.0.2.1's password:

验证

如果连接正常工作,则虚拟机将显示在 Virt Viewer 窗口中。

您可以使用鼠标和键盘与虚拟机控制台以与实际机器交互的方式与虚拟机控制台交互。VM 控制台中的显示反映了虚拟机上正在执行的操作。

故障排除

- 如果在图形控制台中点击没有任何效果,请将控制台扩展为全屏。这是一个已知的鼠标光标偏移问题。

其它资源

-

您系统上的

virt-viewer手册页 - 设置对远程虚拟化主机的简单访问

- 使用 web 控制台与虚拟机交互

2.4.3. 使用 SSH 连接到虚拟机

要使用 SSH 连接协议与虚拟机(VM)终端交互,请按照以下步骤操作。

先决条件

- 有对目标虚拟机的网络连接和 root 访问权限。

- 如果目标虚拟机位于远程主机上,您也可以拥有对该主机的连接和 root 访问权限。

您的虚拟机网络由

libvirt生成的dnsmasq分配 IP 地址。这是libvirtNAT 网络 中的示例。值得注意的是,如果您的虚拟机使用以下网络配置之一,则无法使用 SSH 连接到虚拟机:

-

hostdev接口 - 直接接口

- 网桥接口

-

在虚拟机主机上已安装并启用了

libvirt-nss组件。如果没有,请执行以下操作:安装

libvirt-nss软件包:# yum install libvirt-nss编辑

/etc/nsswitch.conf文件,并将libvirt_guest添加到hosts行中:... passwd: compat shadow: compat group: compat hosts: files libvirt_guest dns ...

流程

当连接到远程虚拟机时,请首先 SSH 到其物理主机。以下示例演示了如何使用其 root 凭证连接到主机

192.0.2.1:# ssh root@192.0.2.1 root@192.0.2.1's password: Last login: Mon Sep 24 12:05:36 2021 root~#使用虚拟机的名称和用户访问凭证来连接它。例如,以下命令使用其 root 凭证连接到

testguest1虚拟机:# ssh root@testguest1 root@testguest1's password: Last login: Wed Sep 12 12:05:36 2018 root~]#

故障排除

如果您不知道虚拟机的名称,您可以使用

virsh list --all命令列出主机上所有可用的虚拟机:# virsh list --all Id Name State ---------------------------------------------------- 2 testguest1 running - testguest2 shut off

其它资源

2.4.4. 打开虚拟机串口控制台

通过使用 virsh console 命令,可以连接到虚拟机(VM)的串行控制台。

但虚拟机有以下情况时很有用:

- 没有提供 VNC 或 SPICE 协议,因此没有为 GUI 工具提供视频显示。

- 没有网络连接,因此无法使用 SSH 进行交互。

先决条件

主机上的 GRUB 引导装载程序必须配置为使用串口控制台。要验证,请检查主机上的

/etc/default/grub文件是否包含GRUB_TERMINAL=serial参数。$ sudo grep GRUB_TERMINAL /etc/default/grub GRUB_TERMINAL=serial虚拟机必须配有一个串口控制台设备,如

console type='pty'。要进行验证,请执行以下操作:# virsh dumpxml vm-name | grep console <console type='pty' tty='/dev/pts/2'> </console>虚拟机必须在内核命令行中配置串口控制台。要验证这一点,虚拟机上的

cat /proc/cmdline命令输出应包含 console=<console-name& gt;,其中 < ;console-name& gt; 是特定于架构的:对于 AMD64 和 Intel 64:

ttyS0注意此流程中的以下命令使用

ttyS0。# cat /proc/cmdline BOOT_IMAGE=/vmlinuz-3.10.0-948.el7.x86_64 root=/dev/mapper/rhel-root ro console=tty0 console=ttyS0,9600n8 rd.lvm.lv=rhel/root rd.lvm.lv=rhel/swap rhgb

如果没有在虚拟机中正确设置串口控制台,请使用 virsh 控制台连接到虚拟机,请将您连接到无响应的客户端控制台。但是,您仍然可以使用 Ctrl+] 快捷键退出无响应控制台。

要在虚拟机上设置串行控制台,请执行以下操作:

在虚拟机上启用

console=ttyS0内核选项:# grubby --update-kernel=ALL --args="console=ttyS0"清除可能会阻止更改生效的内核选项。

# grub2-editenv - unset kernelopts- 重启虚拟机。

必须启用

serial-getty@<console-name> 服务。例如,在 AMD64 和 Intel 64 中:# systemctl status serial-getty@ttyS0.service ○ serial-getty@ttyS0.service - Serial Getty on ttyS0 Loaded: loaded (/usr/lib/systemd/system/serial-getty@.service; enabled; preset: enabled)

流程

在您的主机系统上,使用

virsh console命令。如果 libvirt 驱动程序支持安全控制台处理,以下示例连接到 guest1 虚拟机:# virsh console guest1 --safe Connected to domain 'guest1' Escape character is ^] Subscription-name Kernel 3.10.0-948.el7.x86_64 on an x86_64 localhost login:

- 您还可以使用与标准命令行界面相同的方法与 virsh 控制台互动。

其它资源

-

系统上的

virsh手册页

2.4.5. 设置对远程虚拟化主机的简单访问

当使用 libvirt 工具在远程主机系统上管理虚拟机时,建议使用 -c qemu+ssh://root@hostname/system 语法。例如,要在 192.0.2.1 主机上以 root 用户身份使用 virsh list 命令:

# virsh -c qemu+ssh://root@192.0.2.1/system list

root@192.0.2.1's password:

Id Name State

---------------------------------

1 remote-guest running但是,您可以通过修改 SSH 和 libvirt 配置来删除指定完整连接详情的需要。例如:

# virsh -c remote-host list

root@192.0.2.1's password:

Id Name State

---------------------------------

1 remote-guest running要进行改进,请按照以下步骤操作。

流程

使用以下详细信息编辑

~/.ssh/config文件,其中 host-alias 是与特定远程主机关联的短名称,root@192.0.2.1 和 hosturl 的别名是主机的 URL 地址:# vi ~/.ssh/config Host example-host-alias User root Hostname 192.0.2.1

使用以下详情编辑

/etc/libvirt/libvirt.conf文件,example-qemu-host-alias 是一个 QEMU 和 libvirt 工具将为qemu+ssh://192.0.2.1/system与预期主机 example-host-alias 关联的主机别名:# vi /etc/libvirt/libvirt.conf uri_aliases = [ "example-qemu-host-alias=qemu+ssh://example-host-alias/system", ]

验证

确认通过在本地系统上使用基于 libvirt 的工具,并添加

-c qemu-host-alias参数,您可以来管理远程虚拟机。这会在远程主机中使用 SSH 自动执行命令。例如,验证以下列出了 192.0.2.1 远程主机上的虚拟机,到此主机的连接在前面的步骤中被设置为 example-qemu-host-alias :

# virsh -c example-qemu-host-alias list root@192.0.2.1's password: Id Name State ---------------------------------------- 1 example-remote-guest running注意除了

virsh之外,-c(或--connect)选项以及上述远程主机访问配置也可以由以下工具使用:

后续步骤

如果要在单一远程主机中只使用 libvirt 工具,您也可以为基于 libvirt 的实用程序设置特定的连接作为默认目标。但是,如果您也要管理本地主机或不同远程主机上的虚拟机,则不建议这样做。

您可以编辑

/etc/libvirt/libvirt.conf文件,并将uri_default参数的值设置为 example-qemu-host-alias ,来作为默认的 libvirt 目标。# These can be used in cases when no URI is supplied by the application # (@uri_default also prevents probing of the hypervisor driver). # uri_default = "example-qemu-host-alias"

因此,所有基于 libvirt 的命令都会在指定的远程主机中自动执行。

$ virsh list root@192.0.2.1's password: Id Name State --------------------------------- 1 example-remote-guest running当连接到远程主机时,您可以避免向远程系统提供 root 密码。要做到这一点,请使用以下一个或多个方法:

- 设置对远程主机的基于密钥的 SSH 访问

- 使用 SSH 连接多路复用连接到远程系统

- 身份管理中的 Kerberos 身份验证

-

-c(或--connect)选项可用于在远程主机上运行virt-install、virt-viewer、virsh和virt-manager命令。

2.5. 关闭虚拟机

要关闭托管于 RHEL 8 上的正在运行的虚拟机,请使用 命令行界面 或 Web 控制台 GUI。

2.5.1. 使用命令行界面关闭虚拟机

要关闭响应的虚拟机(VM),请执行以下操作之一:

- 在连接到客户端时,使用适合客户端操作系统的 shutdown 命令。

在主机上使用

virsh shutdown命令:如果虚拟机位于本地主机上:

# virsh shutdown demo-guest1 Domain 'demo-guest1' is being shutdown如果虚拟机在远程主机上,在本例中为 192.0.2.1 :

# virsh -c qemu+ssh://root@192.0.2.1/system shutdown demo-guest1 root@192.0.2.1's password: Domain 'demo-guest1' is being shutdown

要强制虚拟机关闭(例如,如果其机已变得无响应),请在主机上使用 virsh destroy 命令:

# virsh destroy demo-guest1

Domain 'demo-guest1' destroyed

virsh destroy 命令实际上不会删除虚拟机配置或磁盘镜像。它只会终止虚拟机的正在运行的虚拟机实例,类似于从物理机拔掉电源。因此,在个别情况下,virsh destroy 可能会导致虚拟机文件系统崩溃,因此仅在所有其他关闭方法都失败时才建议使用这个命令。

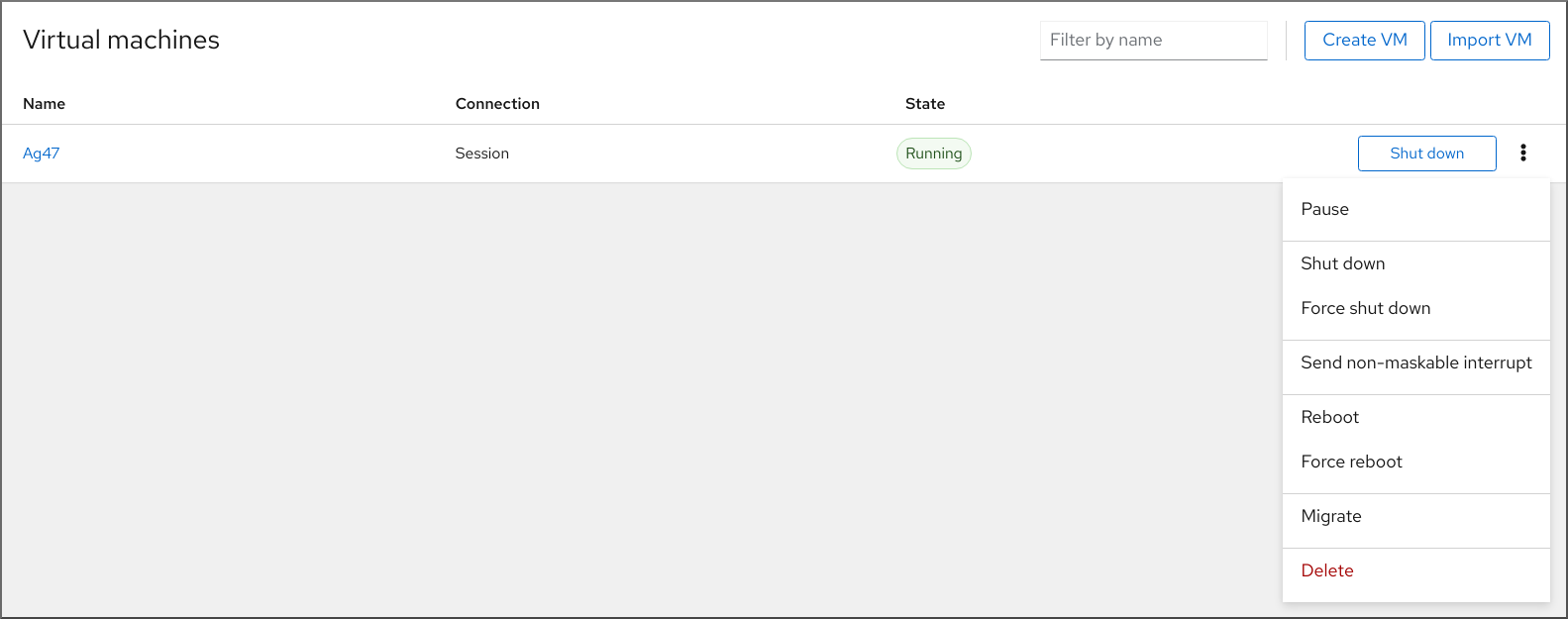

2.5.2. 使用 web 控制台关闭和重启虚拟机

使用 RHEL 8 web 控制台,您可以关闭 或 重启 正在运行的虚拟机。您还可以向无响应的虚拟机发送不可屏蔽中断。

2.5.2.1. 在 web 控制台中关闭虚拟机

如果虚拟机(VM)处于 running 状态,您可以使用 RHEL 8 web 控制台关闭它。

先决条件

已安装 RHEL 8 web 控制台。

具体步骤请参阅安装并启用 Web 控制台。

- Web 控制台 VM 插件 已安装在您的系统上。

流程

- 在 接口中,找到您要关闭的虚拟机行。

在行的右侧,点击 。

虚拟机关机。

故障排除

- 如果虚拟机没有关闭,请点 按钮旁边的 Menu 按钮,然后选择 。

- 要关闭无响应虚拟机,您还可以发送一个不可屏蔽的中断。

2.5.2.2. 使用 web 控制台重启虚拟机

如果虚拟机(VM)处于 running 状态,您可以使用 RHEL 8 web 控制台重启它。

先决条件

已安装 RHEL 8 web 控制台。

具体步骤请参阅安装并启用 Web 控制台。

- Web 控制台 VM 插件 已安装在您的系统上。

流程

- 在 接口中,找到您要重启的虚拟机行。

在行的右侧,点击菜单按钮 。

此时会显示一个下拉操作菜单。

在下拉菜单中,单击 。

虚拟机将关机并重启。

故障排除

- 如果虚拟机没有重启,点 按钮旁边的 Menu 按钮,然后选择 。

- 要关闭无响应虚拟机,您还可以发送一个不可屏蔽的中断。

2.5.2.3. 使用 web 控制台向虚拟机发送不可屏蔽中断

发送不可屏蔽中断(NMI)可能会导致无响应运行的虚拟机(VM)响应或关闭。例如,您可以将 Ctrl+Alt+Del NMI 发送到不响应标准输入的虚拟机。

先决条件

已安装 RHEL 8 web 控制台。

具体步骤请参阅安装并启用 Web 控制台。

- Web 控制台 VM 插件 已安装在您的系统上。

流程

登录到 RHEL 8 web 控制台。

详情请参阅 登录到 web 控制台。

- 在 接口中,找到您要给其发送 NMI 的虚拟机行。

在行的右侧,点击菜单按钮 。

此时会显示一个下拉操作菜单。

在下拉菜单中,点击 。

一个 NMI 发送到虚拟机。

2.6. 删除虚拟机

要在 RHEL 8 中删除虚拟机,请使用 命令行界面 或 web 控制台 GUI。

2.6.1. 使用命令行界面删除虚拟机

要删除虚拟机(VM),您可以使用命令行从主机中删除其 XML 配置和相关存储文件。按照以下步骤操作:

先决条件

- 备份虚拟机中的重要数据。

- 关闭虚拟机。

- 确保没有其他虚拟机使用相同的关联的存储。

流程

使用

virsh undefine工具。例如:以下命令删除 guest1 虚拟机、与其关联的存储卷以及非电压 RAM(若有)。

# virsh undefine guest1 --remove-all-storage --nvram Domain 'guest1' has been undefined Volume 'vda'(/home/images/guest1.qcow2) removed.

其它资源

-

virsh undefine --help命令 -

系统上的

virsh手册页

2.6.2. 使用 web 控制台删除虚拟机

要从 RHEL 8 web 控制台连接的主机中删除虚拟机(VM)及其关联的存储文件,请按照以下步骤操作:

先决条件

已安装 RHEL 8 web 控制台。

具体步骤请参阅安装并启用 Web 控制台。

已安装 RHEL 8 web 控制台。

具体步骤请参阅安装并启用 Web 控制台。

- Web 控制台 VM 插件 已安装在您的系统上。

- 备份虚拟机中的重要数据。

- 确保没有其他虚拟机使用相同的关联存储。

- 可选: 关闭虚拟机。

流程

登录到 RHEL 8 web 控制台。

详情请参阅 登录到 web 控制台。

在界面中,点击您要删除 的虚拟机的 Menu 按钮 。

此时会出现一个下拉菜单,控制各种虚拟机操作。

点击 。

此时会出现确认对话框。

- 可选: 要删除与虚拟机关联的所有或部分存储文件,请选择您要删除的存储文件旁边的复选框。

点击 。

虚拟机和任何选择的存储文件都将被删除。

第 3 章 在 IBM POWER 中使用虚拟化

当在 IBM POWER8 或 POWER9 硬件上使用 RHEL 8 时,您可以使用 KVM 虚拟化。但是,与 AMD64 和 Intel64 构架中的虚拟化相比,在您的系统中启用 KVM 虚拟机管理程序需要额外的步骤。某些 RHEL 8 虚拟化功能在 IBM POWER 上也有 不同或受限的功能。

除以下部分中的信息外,在 IBM POWER 中使用虚拟化与 AMD64 和 Intel64 相同。因此,在 IBM POWER 上使用虚拟化时,您可以查看其他 RHEL 8 虚拟化文档。

3.1. 在 IBM POWER 中启用虚拟化

要在运行 RHEL 8 的 IBM POWER8 或 IBM POWER9 系统上设置 KVM hypervisor 并创建虚拟机(VM),请按照以下说明操作。

先决条件

- 在您的主机上已安装并注册了 RHEL 8 。

有以下最小系统资源可用:

- 主机有 6 GB 可用磁盘空间,以及每个预期的虚拟机需要额外 6 GB 空间。

- 主机需要 2 GB RAM,以及每个预期的虚拟机需要额外 2 GB。

- 主机上有 4 个 CPU。虚拟机通常可以使用单个分配的 vCPU 运行,但红帽建议为每个虚拟机分配 2 个或更多 vCPU,以避免虚拟机在高负载期间变得无响应。

您的 CPU 机器类型必须支持 IBM POWER 虚拟化。

要进行验证,请在

/proc/cpuinfo文件中查询平台信息。# grep ^platform /proc/cpuinfo/ platform : PowerNV如果这个命令的输出包含

PowerNV条目,则您正在运行 PowerNV 机器类型,并可在 IBM POWER 上使用虚拟化。

流程

载入 KVM-HV 内核模块

# modprobe kvm_hv验证是否载入了 KVM 内核模块

# lsmod | grep kvm如果 KVM 成功加载,这个命令的输出会包括

kvm_hv。在虚拟化模块中安装软件包:

# yum module install virt安装

virt-install软件包:# yum install virt-install启动

libvirtd服务。# systemctl start libvirtd

验证

确认您的系统已准备好成为虚拟化主机:

# virt-host-validate [...] QEMU: Checking if device /dev/vhost-net exists : PASS QEMU: Checking if device /dev/net/tun exists : PASS QEMU: Checking for cgroup 'memory' controller support : PASS QEMU: Checking for cgroup 'memory' controller mount-point : PASS [...] QEMU: Checking for cgroup 'blkio' controller support : PASS QEMU: Checking for cgroup 'blkio' controller mount-point : PASS QEMU: Checking if IOMMU is enabled by kernel : PASS如果所有 virt-host-validate 检查返回

PASS值,则您的系统已准备好 创建虚拟机 。如果有任何检查返回

FAIL值,请按照显示的说明来修复问题。如果有任何检查返回

WARN值,请考虑按照显示的说明改进虚拟化功能。

故障排除

如果您的主机 CPU 不支持 KVM 虚拟化,virt-host-validate 会产生以下输出:

QEMU: Checking for hardware virtualization: FAIL (Only emulated CPUs are available, performance will be significantly limited)

但是,在这样的主机系统上的虚拟机将无法引导,而不存在性能问题。

要临时解决这个问题,您可以将虚拟机的 XML 配置中的

<domain type>的值改为qemu。但请注意,红帽不支持使用qemu域类型的虚拟机,在生产环境中不建议这样做。

3.2. IBM POWER 中的虚拟化与 AMD64 和 Intel 64 的不同

IBM POWER 系统上 RHEL 8 中的 KVM 虚拟化在许多方面与 AMD64 和 Intel 64 系统中的 KVM 不同,特别是:

- 内存要求

- IBM POWER 上的虚拟机消耗更多内存。因此,推荐在 IBM POWER 主机上为虚拟机(VM)分配最小内存为 2GB RAM。

- 显示协议

IBM POWER 系统不支持 SPICE 协议。要显示虚拟机的图形化输出,请使用

VNC协议。另外,只支持以下虚拟图形卡设备:-

vga- 仅在-vga std模式中支持,在-vga cirrus模式中不支持. -

virtio-vga -

virtio-gpu

-

- SMBIOOS

- SMBIOS 配置不可用。

- 内存分配错误

POWER8 虚拟机(包括兼容模式虚拟机)可能会因为类似如下的错误而失败:

qemu-kvm: Failed to allocate KVM HPT of order 33 (try smaller maxmem?): Cannot allocate memory

这在使用 RHEL 7.3 及之前作为虚拟机操作系统的虚拟机上发生的可能性更大。

要解决这个问题,请通过将

kvm_cma_resv_ratio= memory添加到主机的内核命令行来增加客户机哈希页表(HPT)的 可用 CMA 内存池,其中 memory 是应为 CMA 池保留的主机内存的百分比(默认为 5)。- 巨页

透明巨页(THP)在 IBM POWER8 虚拟机上不提供任何显著的性能优势。但是 IBM POWER9 虚拟机可以如预期从 THP 中受益。

另外,IBM POWER8 系统中静态巨页的大小为 16 MiB 和 16 GiB,而 AMD64、Intel 64 和 IBM POWER9 上的 2 MiB 和 1 GiB 不同。因此,要将配置有静态巨页的虚拟机从 IBM POWER8 主机迁移到 IBM POWER9 主机,您必须首先在虚拟机上设置 1GiB 巨页。

- kvm-clock

-

不需要为 IBM POWER9 上的虚拟机的时间管理配置

kvm-clock服务。 - pvpanic

IBM POWER9 系统不支持

pvpanic设备。但是在这个构架中默认使用并激活等同的功能。要在虚拟机中启用它,请使用带有preserve值的<on_crash>XML 配置元素。另外,请确保从

<devices>部分中删除<panic>元素,因为它的存在可能会导致虚拟机无法在 IBM POWER 系统上引导。- 单线程主机

- 在 IBM POWER8 系统中,主机机器必须以 单线程模式 运行,才能支持虚拟机。如果安装了 qemu-kvm 软件包,则会自动进行配置。但是,在单线程主机上运行的虚拟机仍然可以使用多个线程。

- 外设设备

IBM POWER 系统中不支持在 AMD64 和 Intel 64 系统上支持很多外设设备,或者支持不同的设备替换。

-

不支持用于 PCI-E 层次结构的设备,包括

ioh3420和xio3130-downstream。此功能由spapr-pci-host-bridge设备提供的多个独立的 PCI root 网桥所取代。 - 不支持 UHCI 和 EHCI PCI 控制器。使用 OHCI 和 XHCI 控制器。

-

不支持 IDE 设备,包括虚拟 IDE CD-ROM

(ide-cd)和虚拟 IDE 磁盘(ide-hd)。改为使用virtio-scsi和virtio-blk设备。 -

不支持仿真 PCI NIC (

rtl8139) 。改为使用virtio-net设备。 -

不支持声音设备,包括

intel-hda、hda-output和AC97。 -

USB 重定向设备,包括

usb-redir和usb-tablet,不支持。

-

不支持用于 PCI-E 层次结构的设备,包括

- v2v 和 p2v

-

virt-v2v和virt-p2v工具仅在 AMD64 和 Intel 64 构架上被支持,且在 IBM POWER 上不提供。

其他资源

- 有关在红帽支持的系统构架中选择支持的和不支持的虚拟化功能的比较,请参阅 RHEL 8 支持的虚拟化功能概述。

第 4 章 在 IBM Z 中使用虚拟化

在 IBM Z 硬件上使用 RHEL 8 时,您可以使用 KVM 虚拟化。但是,与 AMD64 和 Intel 64 构架中的虚拟化相比,在您的系统中启用 KVM 虚拟机管理程序需要额外的步骤。某些 RHEL 8 虚拟化功能在 IBM Z 上也具有 不同的或受限的功能。

除以下部分中的信息外,在 IBM Z 中使用虚拟化与 AMD64 和 Intel64 相同。因此,在使用 IBM Z 上的虚拟化时,您可以查看其他 RHEL 8 虚拟化文档以了解更多信息。

不支持在 z/VM 操作系统上运行 KVM。

4.1. 在 IBM Z 中启用虚拟化

要在运行 RHEL 8 的 IBM Z 系统上设置 KVM hypervisor 并创建虚拟机(VM),请按照以下说明操作。

先决条件

RHEL 8.6 或更高版本已安装并在主机上已注册。

重要如果您使用 RHEL 8.5 或更早版本在 IBM Z 机器上启用了虚拟化,您应该重新配置虚拟化模块并更新您的系统。具体步骤请查看 IBM Z 中的虚拟化与 AMD64 和 Intel 64 不同。

有以下最小系统资源可用:

- 主机有 6 GB 可用磁盘空间,以及每个预期的虚拟机需要额外 6 GB 空间。

- 主机需要 2 GB RAM,以及每个预期的虚拟机需要额外 2 GB。

- 主机上有 4 个 CPU。虚拟机通常可以使用单个分配的 vCPU 运行,但红帽建议为每个虚拟机分配 2 个或更多 vCPU,以避免虚拟机在高负载期间变得无响应。

- 您的 IBM Z 主机系统使用 z13 CPU 或更高版本。

RHEL 8 安装在逻辑分区(LPAR)上。另外,LPAR 支持 启动阶段执行(SIE)虚拟化功能。

要进行验证,请在

/proc/cpuinfo文件中搜索sie。# grep sie /proc/cpuinfo features : esan3 zarch stfle msa ldisp eimm dfp edat etf3eh highgprs te sie

流程

载入 KVM 内核模块:

# modprobe kvm验证是否载入了 KVM 内核模块:

# lsmod | grep kvm如果 KVM 成功加载,这个命令的输出包括会

kvm。在

virt:rhel/common模块中安装软件包:# yum module install virt:rhel/common启动虚拟化服务:

# for drv in qemu network nodedev nwfilter secret storage interface; do systemctl start virt${drv}d{,-ro,-admin}.socket; done

验证

验证您的系统已准备好成为虚拟化主机。

# virt-host-validate [...] QEMU: Checking if device /dev/kvm is accessible : PASS QEMU: Checking if device /dev/vhost-net exists : PASS QEMU: Checking if device /dev/net/tun exists : PASS QEMU: Checking for cgroup 'memory' controller support : PASS QEMU: Checking for cgroup 'memory' controller mount-point : PASS [...]如果所有 virt-host-validate 检查返回

PASS值,则您的系统已准备好 创建虚拟机 。如果有任何检查返回

FAIL值,请按照显示的说明来修复问题。如果有任何检查返回

WARN值,请考虑按照显示的说明改进虚拟化功能。

故障排除

如果您的主机 CPU 不支持 KVM 虚拟化,virt-host-validate 会产生以下输出:

QEMU: Checking for hardware virtualization: FAIL (Only emulated CPUs are available, performance will be significantly limited)

但是,在这样的主机系统上的虚拟机将无法引导,而不存在性能问题。

要临时解决这个问题,您可以将虚拟机的 XML 配置中的

<domain type>的值改为qemu。但请注意,红帽不支持使用qemu域类型的虚拟机,在生产环境中不建议这样做。

4.2. 将 IBM Z 上的虚拟化从 RHEL 8.5 更新至 RHEL 8.6 或更高版本

如果您在 RHEL 8.6 之前的 IBM Z 硬件上安装 RHEL 8,则需要从 AV 流获取虚拟化 RPM,与 RHEL 8 基本 RPM 流分开。从 RHEL 8.6 开始,以前从 AV 流提供的虚拟化 RPM 只在基本 RHEL 流中可用。另外,在以后的 RHEL 8 次要发行本中将停用 AV 流。因此,不再支持使用 AV 流。

按照下面的说明,您将取消激活您的 AV 流,并允许访问 RHEL 8.6 及更高版本中提供的虚拟化 RPM。

先决条件

您会在 IBM Z 上使用 RHEL 8.5,安装

virt:av模块。确认情况确实如此:# hostnamectl | grep "Operating System" Operating System: Red Hat Enterprise Linux 8.5 (Ootpa) # yum module list --installed [...] Advanced Virtualization for RHEL 8 IBM Z Systems (RPMs) Name Stream Profiles Summary virt av [e] common [i] Virtualization module

流程

禁用

virt:av模块。# yum disable virt:av删除您系统上已经包含的预先存在的虚拟化软件包和模块。

# yum module reset virt -y将软件包升级到最新的 RHEL 版本。

# yum update这也会在系统上自动启用

virt:rhel模块。

验证

确定您的系统中的

virt模块由rhel流提供。# yum module info virt Name : virt Stream : rhel [d][e][a] Version : 8050020211203195115 [...]

4.3. IBM Z 上的虚拟化与 AMD64 和 Intel 64 有什么不同

IBM Z 系统上 RHEL 8 中的 KVM 虚拟化与 AMD64 和 Intel 64 系统上的 KVM 在以下方面有所不同:

- PCI 和 USB 设备

IBM Z 不支持虚拟 PCI 和 USB 设备。这意味着不支持

virtio-*-pci设备,应该改为使用virtio-*-ccw设备。例如,使用virtio-net-ccw而不是virtio-net-pci。请注意,支持直接附加 PCI 设备(也称 PCI 透传)。

- 支持的客户端操作系统

- 如果红帽只使用 RHEL 7、8 或 9 作为客户机操作系统,红帽只支持在 IBM Z 上托管的虚拟机。

- 设备引导顺序

IBM Z 不支持

<boot dev='device'>XML 配置元素。要定义设备引导顺序,请使用 XML 的<devices>部分中的<boot order='number'>元素。另外,您可以使用 <boot> 元素中的特定于 architecture 的

loadparm属性来选择所需的引导条目。例如,以下决定在引导序列中最先使用磁盘,以及该磁盘上是否有 Linux 发行版可用,它将选择第二个引导条目:<disk type='file' device='disk'> <driver name='qemu' type='qcow2'/> <source file='/path/to/qcow2'/> <target dev='vda' bus='virtio'/> <address type='ccw' cssid='0xfe' ssid='0x0' devno='0x0000'/> <boot order='1' loadparm='2'/> </disk>

注意在 AMD64 和 Intel 64 主机上,首选使用 <

boot order='number'> 进行引导顺序管理。- 内存热插拔

- 在 IBM Z 上无法将内存添加到正在运行的虚拟机。请注意,在 IBM Z 上,以及 AMD64 和 Intel64 上,从正在运行的虚拟机(内存热插拔)中不可能删除内存。

- NUMA 拓扑

-

IBM Z 上的

libvirt不支持 CPU 的非统一内存访问(NUMA)拓扑。因此,在这些系统上无法使用 NUMA 调整 vCPU 性能。 - GPU 设备

- IBM Z 系统不支持 分配 GPU 设备。

- vfio-ap

- IBM Z 主机上的虚拟机可以使用 vfio-ap 加密设备透传,其它构架都不支持它。

- vfio-ccw

- IBM Z 主机上的虚拟机可以使用 vfio-ccw 磁盘设备透传,其它构架都不支持它。

- SMBIOOS

- IBM Z 不提供 SMBIOS 配置。

- watchdog 设备

如果在 IBM Z 主机上的虚拟机中使用看门狗设备,请使用

diag288模型。例如:<devices> <watchdog model='diag288' action='poweroff'/> </devices>

- kvm-clock

-

kvm-clock服务特定于 AMD64 和 Intel 64 系统,不需要为 IBM Z 上的虚拟机时间管理配置。 - v2v 和 p2v

-

virt-v2v和virt-p2v工具仅在 AMD64 和 Intel 64 构架上支持,在 IBM Z 上不提供。 - 嵌套虚拟化

- 创建嵌套虚拟机需要在 IBM Z 上进行与 AMD64 和 Intel64 的不同设置。详情请参阅 创建嵌套虚拟机。

- 早期版本中没有图形输出

-

当在主机上使用 RHEL 8.3 或更早的次版本时,当使用 VNC 协议连接到虚拟机时,无法显示虚拟机图形输出。这是因为 IBM Z 上的早期 RHEL 版本不支持

gnome-desktop工具。此外,SPICE 显示协议不适用于 IBM Z。 - 迁移

要成功迁移到以后的主机型号(例如从 IBM z14 到 z15),或更新 hypervisor ,请使用

host-modelCPU 模式。不建议使用host-passthrough和maximumCPU 模式,因为它们通常不适合迁移。如果要在

customCPU 模式中指定明确的 CPU 模式,请按照以下步骤操作:-

不要使用以

-base结尾的 CPU 模式。 -

不要使用

qemu、max或hostCPU 模式。

要成功迁移到较旧的主机型号(如从 z15 到 z14),或者迁移到早期版本的 QEMU、KVM 或 RHEL 内核,请使用结尾没有

-base的最老的可用的主机型号的 CPU 类型。-

如果源主机和目标主机正在运行,您可以在目标主机上使用

virsh hypervisor-cpu-baseline命令来获取合适的 CPU 模型。详情请参阅 验证虚拟机迁移的主机 CPU 兼容性。 - 有关 RHEL 8 中支持的机器类型的更多信息,请参阅 RHEL 8 虚拟化中推荐的功能。

-

不要使用以

- PXE 安装和引导

当使用 PXE 在 IBM Z 上运行虚拟机时,

pxelinux.cfg/default文件需要一个特定的配置。例如:# pxelinux default linux label linux kernel kernel.img initrd initrd.img append ip=dhcp inst.repo=example.com/redhat/BaseOS/s390x/os/

- 安全执行

-

您可以通过在虚拟机 XML 配置中定义 <

launchSecurity type="s390-pv"/> 来引导带有准备好的安全客户机镜像的虚拟机。这会加密虚拟机的内存来保护它不受虚拟机监控程序不需要的访问。

请注意,在以安全执行模式运行虚拟机时不支持以下功能:

-

使用

vfio的设备透传 -

使用

virsh domstats和virsh memstat获取内存信息 -

memballoon和virtio-rng虚拟设备 - 使用巨页支持内存

- 实时和非实时迁移

- 保存和恢复虚拟机

-

虚拟机快照,包括内存快照(使用

--memspec选项) -

完整内存转储。反之,为

virsh dump命令指定--memory-only选项。 - 248 或更多 vCPU。安全客户机的 vCPU 限值为 247。

- 嵌套虚拟化

其它资源

4.4. 后续步骤

在 IBM Z 系统上设置虚拟机时,建议保护客户机操作系统不受 "Spectre" 漏洞的影响。要做到这一点,请使用

virsh edit命令修改虚拟机的 XML 配置,并使用以下方法之一配置其 CPU:使用主机 CPU 模式:

<cpu mode='host-model' check='partial'> <model fallback='allow'/> </cpu>

这使得

ppa15和bpb功能可供虚拟客户机使用(如果主机支持这两个功能)。如果使用特定的主机模式,请添加

ppa15和pbp功能。以下示例使用 zEC12 CPU 模型:<cpu mode='custom' match='exact' check='partial'> <model fallback='allow'>zEC12</model> <feature policy='force' name='ppa15'/> <feature policy='force' name='bpb'/> </cpu>请注意,当在使用 z12 CPU 的主机机器上将

ppa15功能与z114和z196CPU 模式一起使用时,您还需要使用最新的微码级别(bundle 95 或更高版本)。

第 5 章 在虚拟机上启用 QEMU 客户机代理功能

要在 RHEL 8 系统中托管的虚拟机(VM)中使用某些功能,您必须首先将虚拟机配置为使用 QEMU 客户机代理(GA)。

有关这些功能的完整列表,请参阅 需要 QEMU 客户机代理的虚拟化功能。

在虚拟机上配置 QEMU GA 所需的具体步骤因虚拟机使用的客户机操作系统而异:

- 对于 Linux 虚拟机,请参阅 在 Linux 客户机上启用 QEMU 客户机代理。

- 对于 Windows 虚拟机,请参阅 在 Windows 客户机上启用 QEMU 客户机代理。

5.1. 在 Linux 客户机上启用 QEMU 客户机代理

要允许 RHEL 主机在 Linux 虚拟机(VM)上执行 某些操作的子集,您必须启用 QEMU 客户机代理(GA)。

您可以在运行和关闭的虚拟机上启用 QEMU GA。

流程

为 QEMU GA 创建一个 XML 配置文件,例如

qemuga.xml:# touch qemuga.xml在文件中添加以下行:

<channel type='unix'> <source mode='bind' path='/var/lib/libvirt/qemu/f16x86_64.agent'/> <target type='virtio' name='org.qemu.guest_agent.0'/> </channel>

使用 XML 文件将 QEMU GA 添加导虚拟机的配置中。

如果虚拟机正在运行,请使用以下命令:

# virsh attach-device <vm-name> qemuga.xml --live --config如果虚拟机已关闭,请使用以下命令:

# virsh attach-device <vm-name> qemuga.xml --config

在 Linux 客户机操作系统中,安装 QEMU GA:

# yum install qemu-guest-agent在客户机上启动 QEMU GA 服务:

# systemctl start qemu-guest-agent

验证

要确保 QEMU GA 已启用并在 Linux 虚拟机上运行,请执行以下操作之一:

-

在客户机操作系统中,请使用

systemctl status qemu-guest-agent | grep Loaded命令。如果输出包括enabled,则 QEMU GA 在虚拟机上处于活跃状态。 -

在主机上使用

virsh domfsinfo <vm-name>命令。如果其显示任何输出,则 QEMU GA 在指定虚拟机上处于活跃状态。

其它资源

5.2. 在 Windows 客户机上启用 QEMU 客户机代理

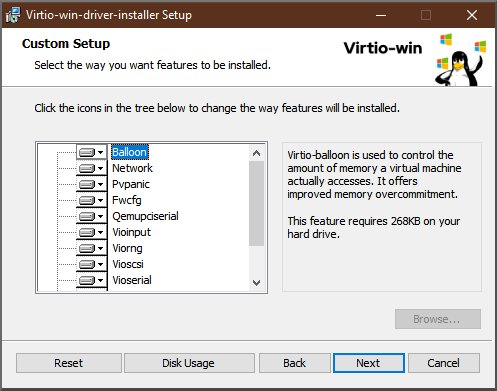

要允许 RHEL 主机在 Windows 虚拟机(VM)上执行 某些操作的子集,您必须启用 QEMU 客户机代理(GA)。为此,请将包含 QEMU 客户机代理安装程序的存储设备添加到现有虚拟机或者在创建新虚拟机时,在 Windows 客户机操作系统上安装驱动程序。

要使用图形界面安装客户机代理(GA),请参阅以下流程 。要在命令行界面中安装 GA,请使用 Microsoft Windows 安装程序(MSI)。

先决条件

- 带有客户机代理的安装介质被附加到虚拟机。有关准备介质的说明,请参考 在主机上准备 virtio 驱动程序安装介质。

流程

-

在 Windows 客户机操作系统中,打开

File Explorer应用程序。 -

单击

This PC。 -

在

Devices and drives窗格中,打开virtio-win介质。 -

打开

guest-agent文件夹。 根据安装在虚拟机上的操作系统,运行以下一个安装程序:

-

如果使用 32 位操作系统,请运行

qemu-ga-i386.msi安装程序。 -

如果使用 64 位操作系统,请运行

qemu-ga-x86_64.msi安装程序。

-

如果使用 32 位操作系统,请运行

-

可选:如果要使用半虚拟化串行驱动程序(

virtio-serial)作为主机和 Windows 客户机之间的通信接口,请验证在 Windows 客户机上是否安装了virtio-serial驱动程序。有关安装virtio驱动程序的更多信息,请参阅: 在 Windows 客户机 上安装 virtio 驱动程序。

验证

在 Windows 虚拟机上,进到 Services 窗口。

Computer Management > Services

-

确保

QEMU 客户机代理服务的状态为Running。

其它资源

5.3. 需要 QEMU 客户机代理的虚拟化功能

如果您在虚拟机(VM)上启用了 QEMU 客户机代理(GA),您可以在主机上使用以下命令来管理虚拟机:

virsh shutdown --mode=agent-

这个关闭方法比

virsh shutdown --mode=acpi更可靠,因为与 QEMU GA 一起使用的virsh shutdown可以保证在干净的状态下关闭合作客户机。

virsh domfsfreeze和virsh domfsthaw- 冻结处于隔离状态的客户机文件系统。

virsh domfstrim指示客户机修剪其文件系统,这有助于减少迁移期间需要传输的数据。

重要如果要使用这个命令管理 Linux 虚拟机,您还必须在客户机操作系统中设置以下 SELinux 布尔值:

# setsebool virt_qemu_ga_read_nonsecurity_files onvirsh domtime- 查询或设置客户机时钟。

virsh setvcpus --guest- 指示客户机将 CPU 离线,这在无法热拔 CPU 时非常有用。

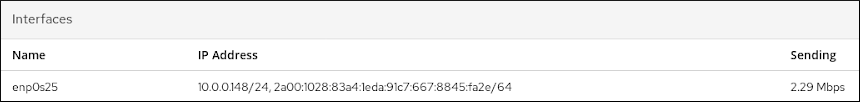

virsh domifaddr --source agent- 使用 QEMU GA 查询客户机操作系统的 IP 地址。例如,当客户机接口直接连接到主机接口时,这非常有用。

virsh domfsinfo- 显示正在运行的客户机中挂载的文件系统的列表。

virsh set-user-password- 在客户机中设置给定用户帐户的密码。

virsh set-user-sshkeys客户机中编辑给定用户的授权的 SSH 密钥文件。

重要如果要使用这个命令管理 Linux 虚拟机,您还必须在客户机操作系统中设置以下 SELinux 布尔值:

# setsebool virt_qemu_ga_manage_ssh on

第 6 章 在 web 控制台中管理虚拟机

要在 RHEL 8 主机上的图形界面中管理虚拟机,您可以使用 RHEL 8 web 控制台中的 Virtual Machines 窗格。

6.1. 使用 web 控制台管理虚拟机概述

RHEL 8 web 控制台是一个用于系统管理的基于 web 的界面。作为其功能之一,Web 控制台提供主机系统中虚拟机(VM)的图形视图,并可创建、访问和配置这些虚拟机。

请注意,要使用 Web 控制台管理 RHEL 8 上的虚拟机,您必须首先安装用于虚拟化的 web 控制台插件。

后续步骤

- 有关在 web 控制台中启用虚拟机管理的说明,请参阅 设置 Web 控制台来管理虚拟机。

- 有关 web 控制台提供的虚拟机管理操作的完整列表,请参阅 web 控制台中提供的虚拟机管理功能。

- 有关 web 控制台中目前不可用但在 virt-manager 应用程序中可以使用的功能列表,请参阅 虚拟机管理器和 Web 控制台中虚拟化功能之间的区别。

6.2. 设置 web 控制台以管理虚拟机

在使用 RHEL 8 web 控制台管理虚拟机(VM)之前,您必须在主机上安装 web 控制台虚拟机插件。

先决条件

已安装 RHEL 8 web 控制台。

具体步骤请参阅安装并启用 Web 控制台。

流程

安装

cockpit-machines插件。# yum install cockpit-machines

验证

登录到 RHEL 8 web 控制台。

详情请参阅 登录到 web 控制台。

如果安装成功,则 会显示在 web 控制台侧菜单中。

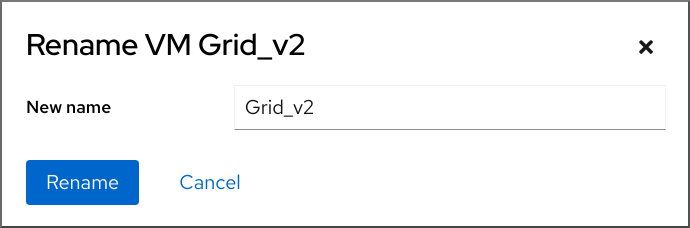

6.3. 使用 web 控制台重命名虚拟机

您可能需要重命名现有的虚拟机(VM)以避免命名冲突,或者根据您的用例分配一个新的唯一名称。要重命名虚拟机,您可以使用 RHEL web 控制台。

先决条件

已安装 RHEL 8 web 控制台。

具体步骤请参阅安装并启用 Web 控制台。

- Web 控制台 VM 插件 已安装在您的系统上。

- 虚拟机已关闭。

流程

在 界面中,点击您要重命名的虚拟机的菜单按钮 。

此时会出现一个具有控制各种虚拟机操作的下拉菜单。

点击 。

此时会出现 Rename a VM 对话框。

- 在 New name 字段中输入虚拟机的名称。

- 点击 。

验证

- 检查新虚拟机名称是否已出现在 界面中。

6.4. web 控制台中提供的虚拟机管理功能

通过使用 RHEL 8 web 控制台,您可以执行以下操作来管理系统上的虚拟机(VM)。

| 任务 | 详情请查看 |

|---|---|

| 创建虚拟机并将其安装到客户端操作系统 | |

| 删除虚拟机 | |

| 启动、关闭和重启虚拟机 | |

| 使用各种控制台连接到虚拟机并与虚拟机交互 | |

| 查看有关虚拟机的各种信息 | |

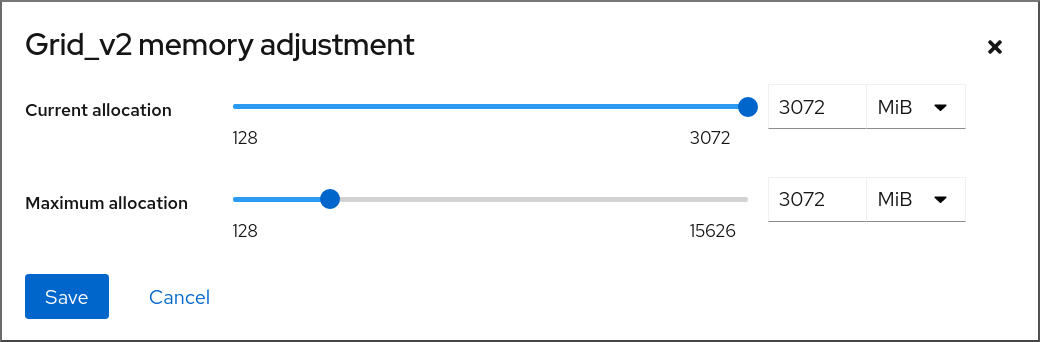

| 调整分配给虚拟机的主机内存 | |

| 管理虚拟机的网络连接 | |

| 管理主机上可用的虚拟机存储,并将虚拟磁盘附加到虚拟机 | |

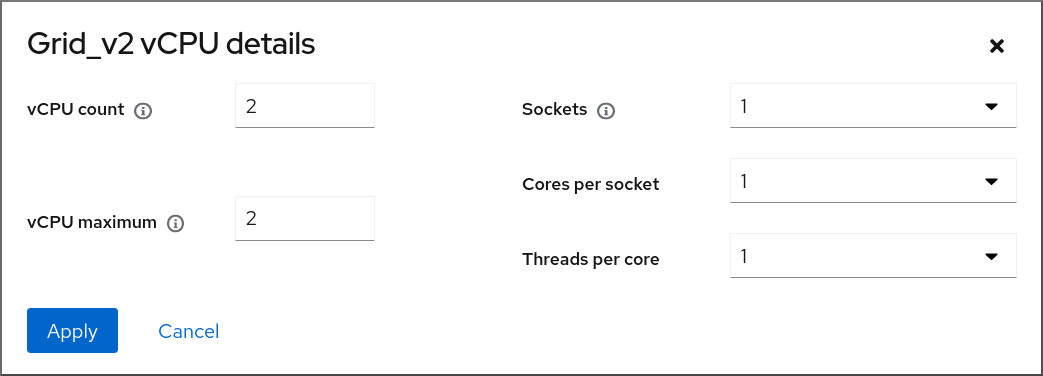

| 配置虚拟机的虚拟 CPU 设置 | |

| 实时迁移虚拟机 | |

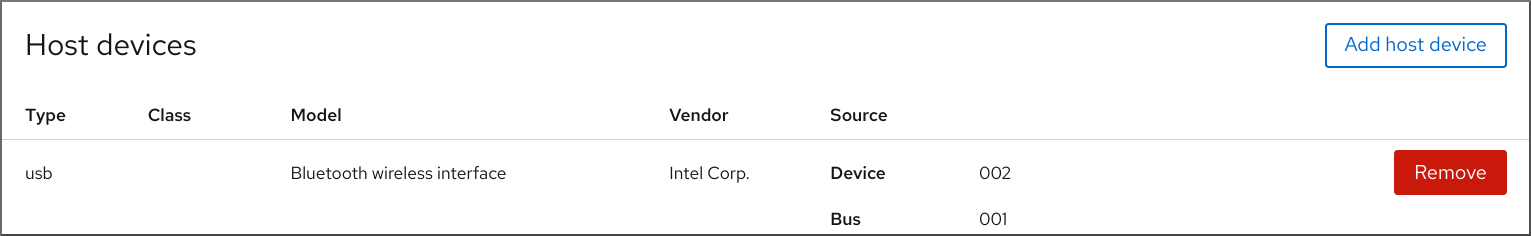

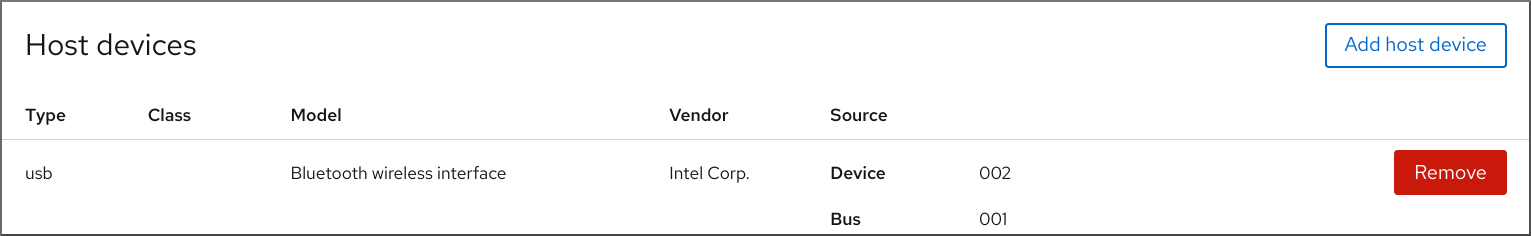

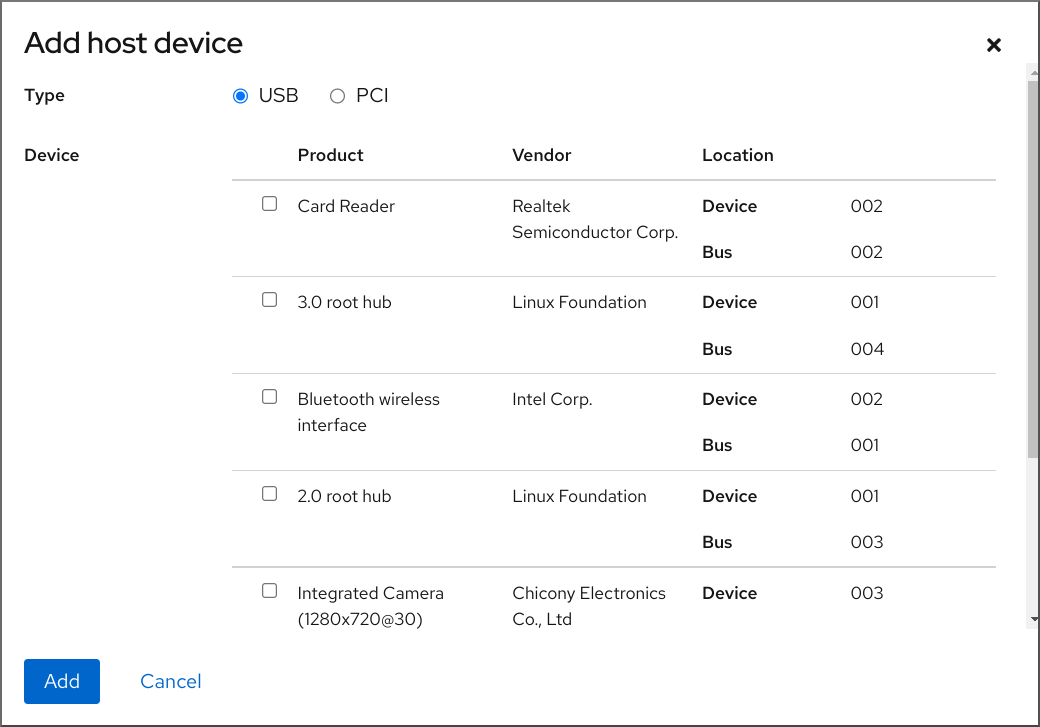

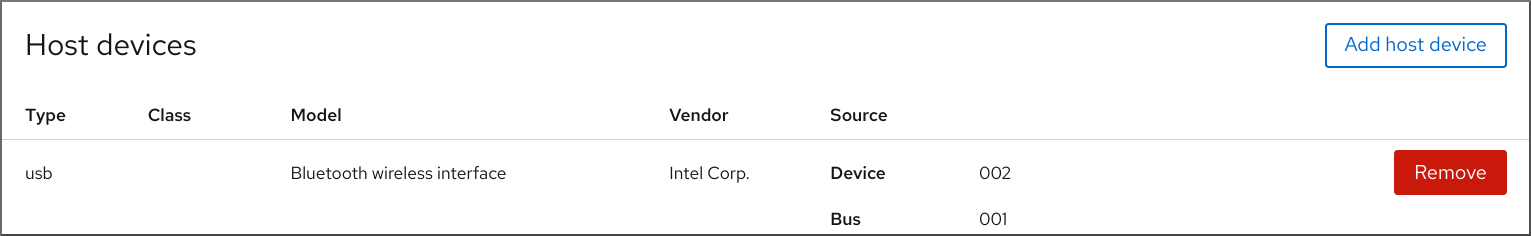

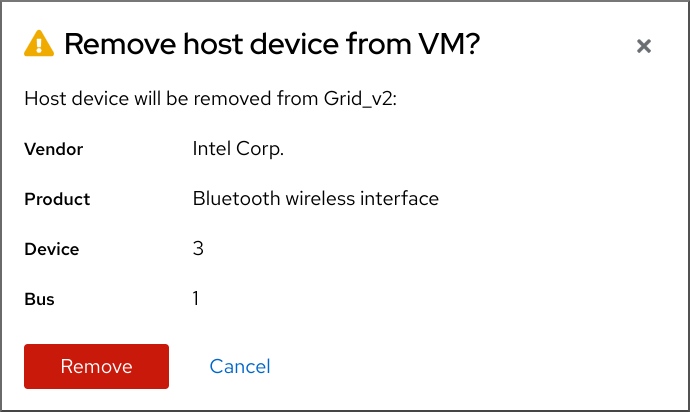

| 管理主机设备 | |

| 管理虚拟光驱 | |

| 附加 watchdog 设备 |

6.5. 虚拟机管理器和 web 控制台中虚拟化功能的不同

RHEL 8 支持虚拟机管理器(virt-manager)应用程序,但已弃用。Web 控制台旨在在以后的主发行版本中替换。因此,建议您熟悉通过 web 控制台使用 GUI 管理虚拟化。

但是,在 RHEL 8 中,某些虚拟机管理任务只能在 virt-manager 或命令行中执行。下表主要介绍 virt-manager 中可用但没有在 RHEL 8.0 web 控制台中提供的功能。

如果在 RHEL 8 的后续次要版本中提供了此功能,则在 Support in web console introduced 列中会显示最低的 RHEL 8 版本。

| 任务 | 引入的 Web 控制台支持 | 使用 CLI 的替代方法 |

|---|---|---|

| 将虚拟机设置为在主机引导时启动 | RHEL 8.1 |

|

| 挂起虚拟机 | RHEL 8.1 |

|

| 恢复挂起的虚拟机 | RHEL 8.1 |

|

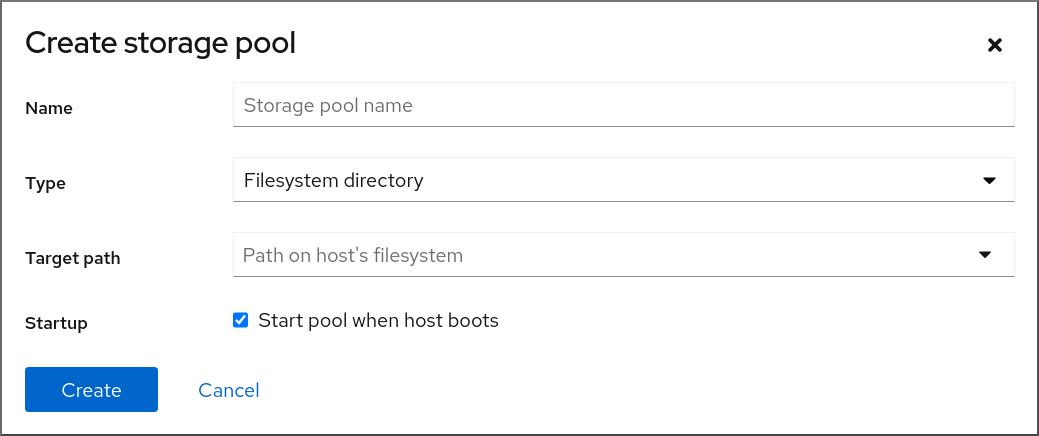

| 创建文件系统目录存储池 | RHEL 8.1 |

|

| 创建 NFS 存储池 | RHEL 8.1 |

|

| 创建物理磁盘设备存储池 | RHEL 8.1 |

|

| 创建 LVM 卷组存储池 | RHEL 8.1 |

|

| 创建基于分区的存储池 | 当前不可用 |

|

| 创建基于 GlusterFS 的存储池 | 当前不可用 |

|

| 使用 SCSI 设备创建基于 vHBA 的存储池 | 当前不可用 |

|

| 创建基于多路径的存储池 | 当前不可用 |

|

| 创建基于 RBD 的存储池 | 当前不可用 |

|

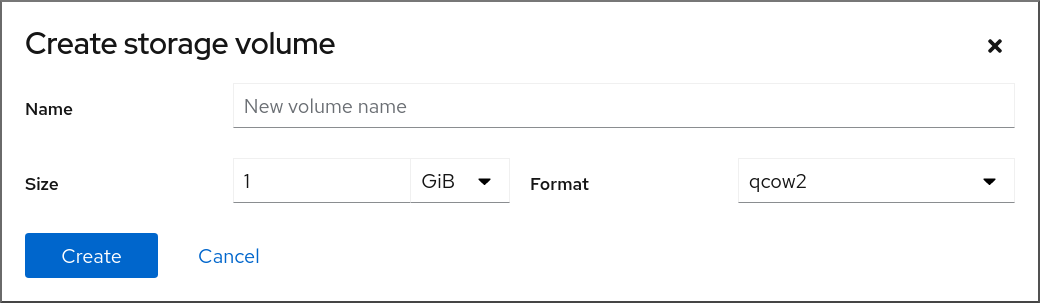

| 创建新存储卷 | RHEL 8.1 |

|

| 添加一个新的虚拟网络 | RHEL 8.1 |

|

| 删除虚拟网络 | RHEL 8.1 |

|

| 从主机机器接口创建到虚拟机的桥接 | 当前不可用 |

|

| 创建快照 | 当前不可用 |

|

| 恢复到快照 | 当前不可用 |

|

| 删除快照 | 当前不可用 |

|

| 克隆虚拟机 | RHEL 8.4 |

|

| 将虚拟机迁移到另一台主机机器中 | RHEL 8.5 |

|

| 将主机设备附加到虚拟机 | RHEL 8.5 |

|

| 从虚拟机中删除主机设备 | RHEL 8.5 |

|

第 7 章 查看有关虚拟机的信息

当需要在 RHEL 8 上调整或排除虚拟化部署的任何方面时,您需要执行的第一个步骤通常是查看有关虚拟机的当前状态和配置的信息。要做到这一点,您可以使用 命令行界面 或 Web 控制台。您还可以查看虚拟机 XML 配置中的信息。

7.1. 使用命令行界面查看虚拟机信息

要检索主机上虚拟机(VM)的信息,请使用以下一个或多个命令。

流程

获取主机上的虚拟机列表:

# virsh list --all Id Name State ---------------------------------- 1 testguest1 running - testguest2 shut off - testguest3 shut off - testguest4 shut off要获取有关特定虚拟机的基本信息:

# virsh dominfo testguest1 Id: 1 Name: testguest1 UUID: a973666f-2f6e-415a-8949-75a7a98569e1 OS Type: hvm State: running CPU(s): 2 CPU time: 188.3s Max memory: 4194304 KiB Used memory: 4194304 KiB Persistent: yes Autostart: disable Managed save: no Security model: selinux Security DOI: 0 Security label: system_u:system_r:svirt_t:s0:c486,c538 (enforcing)要获得特定虚拟机的完整 XML 配置:

# virsh dumpxml testguest2 <domain type='kvm' id='1'> <name>testguest2</name> <uuid>a973434f-2f6e-4ěša-8949-76a7a98569e1</uuid> <metadata> [...]有关虚拟机 XML 配置的注解示例,请参阅示例虚拟机 XML 配置

有关虚拟机磁盘和其它块设备的详情:

# virsh domblklist testguest3 Target Source --------------------------------------------------------------- vda /var/lib/libvirt/images/testguest3.qcow2 sda - sdb /home/username/Downloads/virt-p2v-1.36.10-1.el7.iso有关管理虚拟机存储的说明,请参阅 管理虚拟机的存储。

要获取有关虚拟机文件系统及其挂载点的信息:

# virsh domfsinfo testguest3 Mountpoint Name Type Target ------------------------------------ / dm-0 xfs /boot vda1 xfs

要获取有关特定虚拟机 vCPU 的详细信息:

# virsh vcpuinfo testguest4 VCPU: 0 CPU: 3 State: running CPU time: 103.1s CPU Affinity: yyyy VCPU: 1 CPU: 0 State: running CPU time: 88.6s CPU Affinity: yyyy要在虚拟机中配置和优化 vCPU,请参阅 优化虚拟机 CPU 性能。

列出主机上的所有虚拟网络接口:

# virsh net-list --all Name State Autostart Persistent --------------------------------------------- default active yes yes labnet active yes yes有关特定接口的详情:

# virsh net-info default Name: default UUID: c699f9f6-9202-4ca8-91d0-6b8cb9024116 Active: yes Persistent: yes Autostart: yes Bridge: virbr0有关网络接口、虚拟机网络和配置它们的说明,请参阅配置虚拟机网络连接。

- 有关查看主机上存储池和存储卷的信息,请参阅使用 CLI 查看虚拟机存储信息。

7.2. 使用 web 控制台查看虚拟机信息

通过使用 RHEL 8 web 控制台,您可以查看 web 控制台会话可以访问 的所有虚拟机 和 存储池的信息。

您可以查看 web 控制台会话连接到的所选虚拟机的信息。这包括其 磁盘、虚拟网络接口和资源使用情况 的信息。

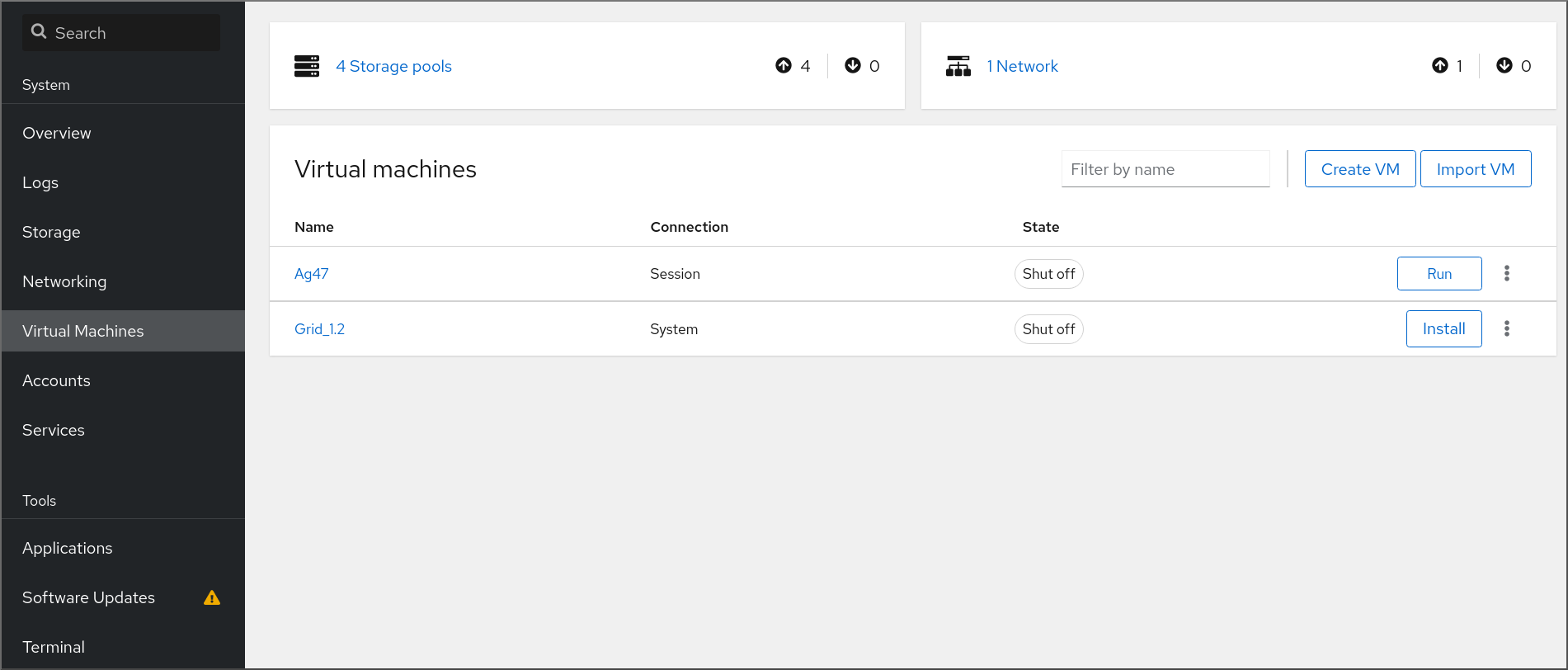

7.2.1. 在 web 控制台中查看虚拟化概述

通过使用 web 控制台,您可以访问虚拟化概述,其中包含有关可用虚拟机(VM)、存储池和网络的总结信息。

先决条件

- Web 控制台 VM 插件 已安装在您的系统上。

流程

在 web 控制台侧菜单中点击 。

此时将显示一个对话框,其中包含有关 Web 控制台所连接的可用存储池、可用网络和虚拟机的信息。

该信息包括:

- 存储池 - 可以通过 Web 控制台及其状态访问的活动的或非活动的存储池数量。

- 网络 - 可以通过 Web 控制台及其状态访问的活动的或非活动的网络数量。

- Name - 虚拟机的名称。

- Connection - libvirt 连接、系统或者会话的类型。

- State - 虚拟机的状态。

其它资源

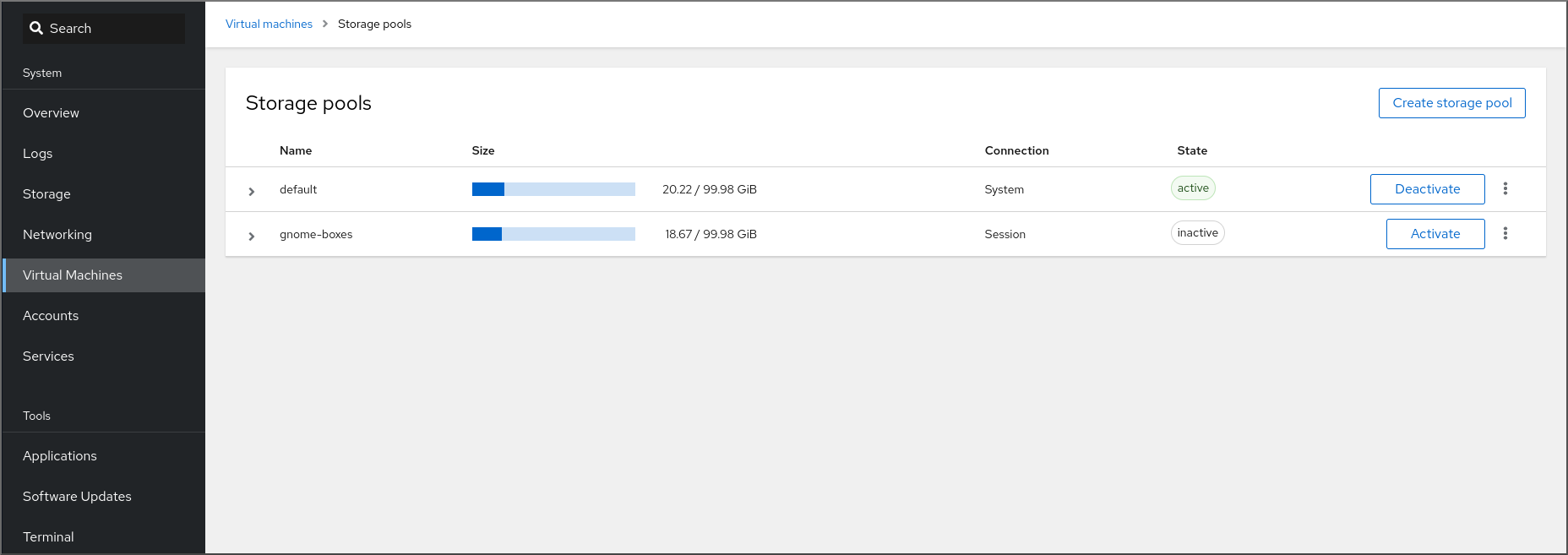

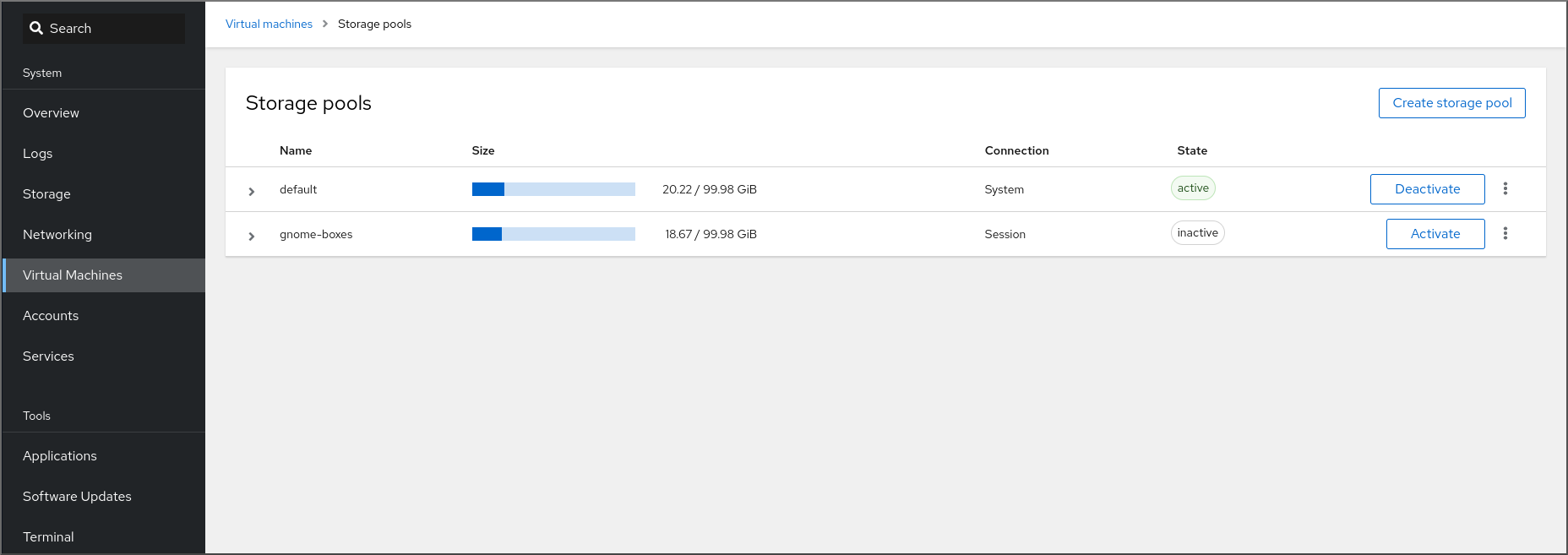

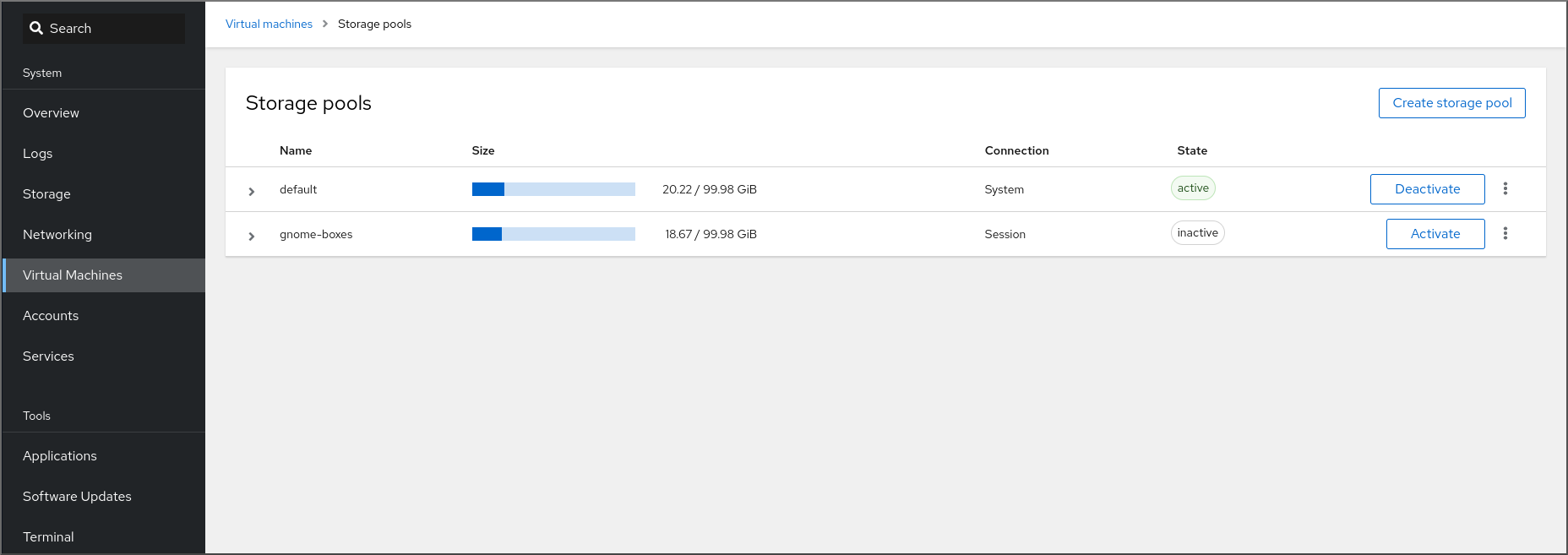

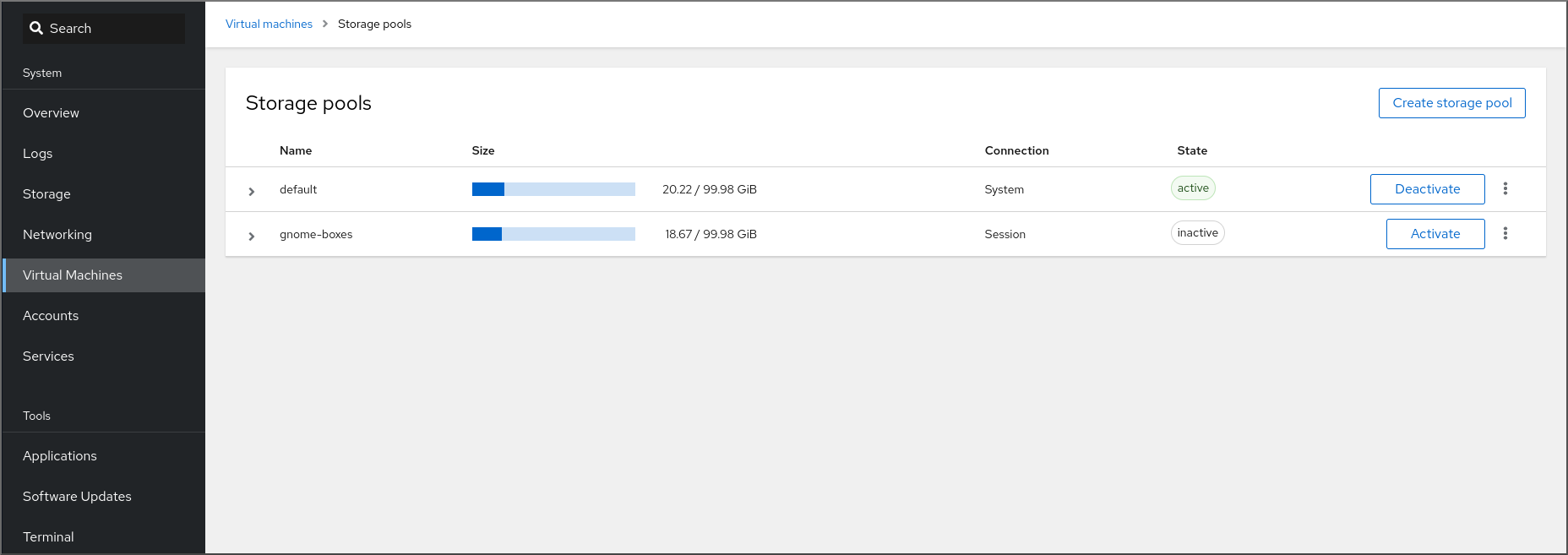

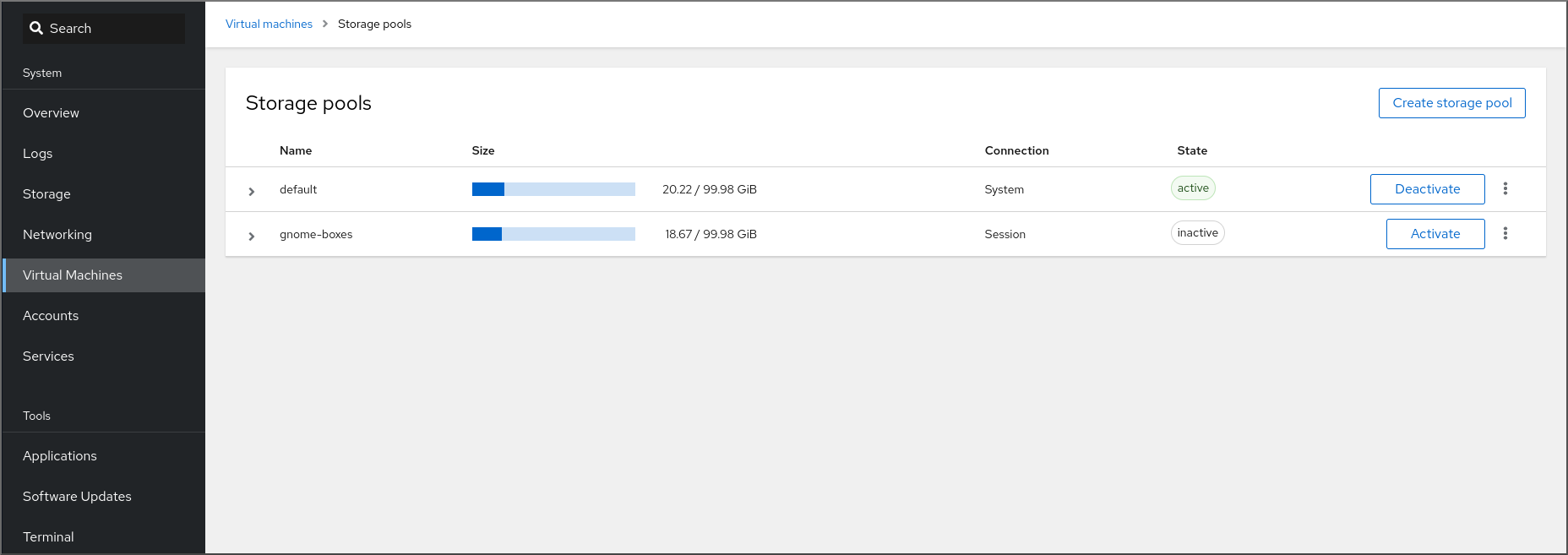

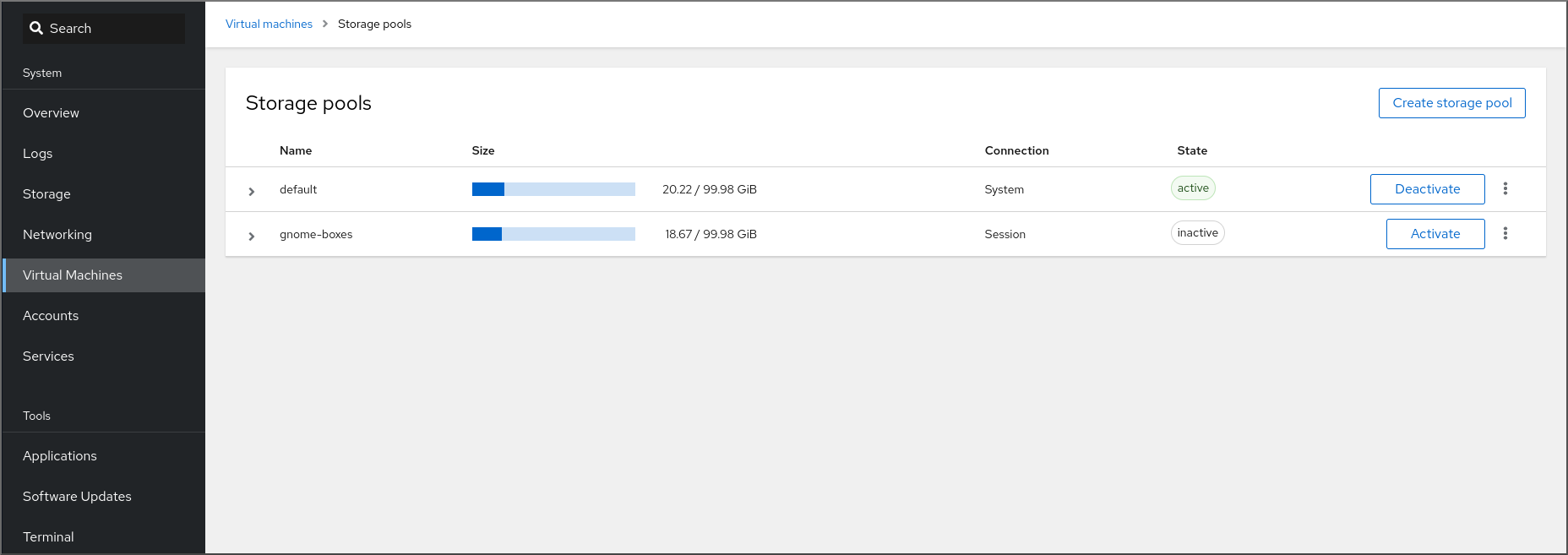

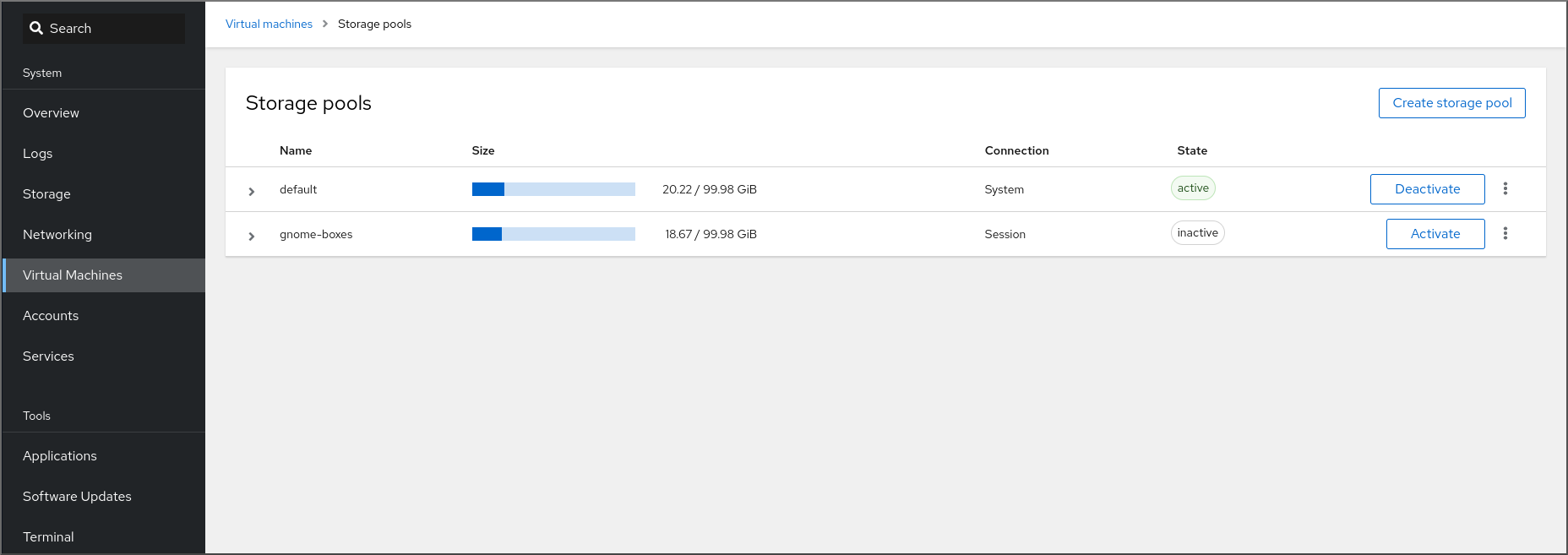

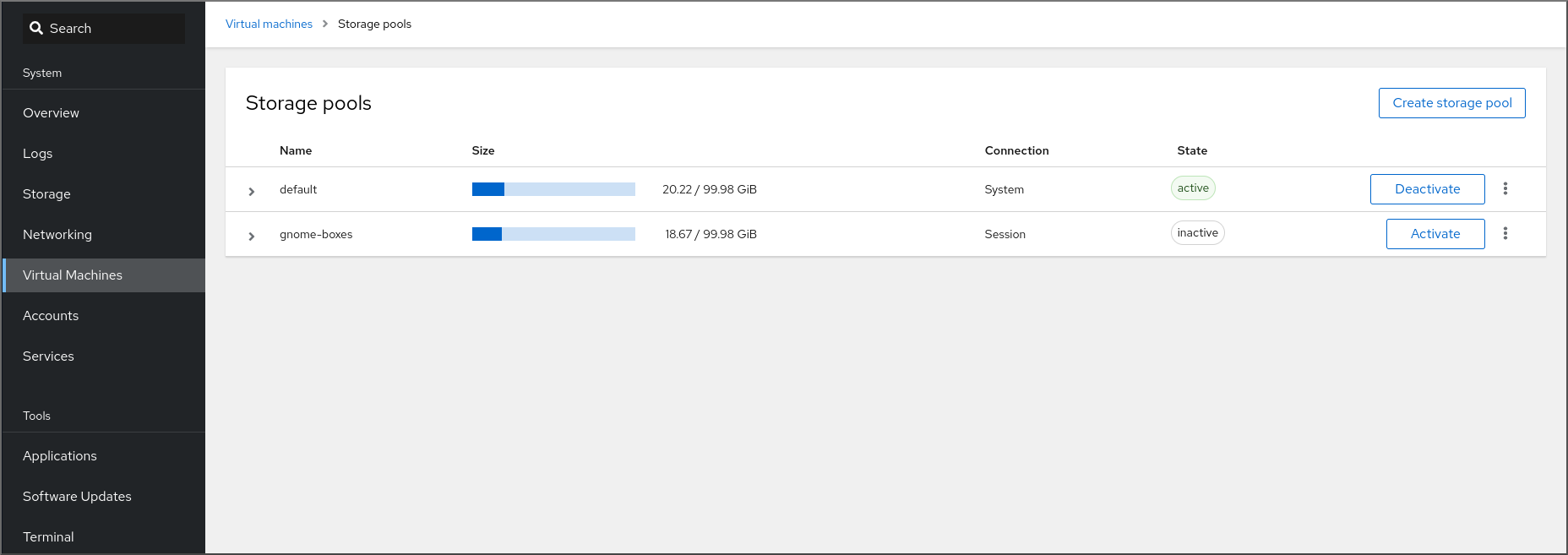

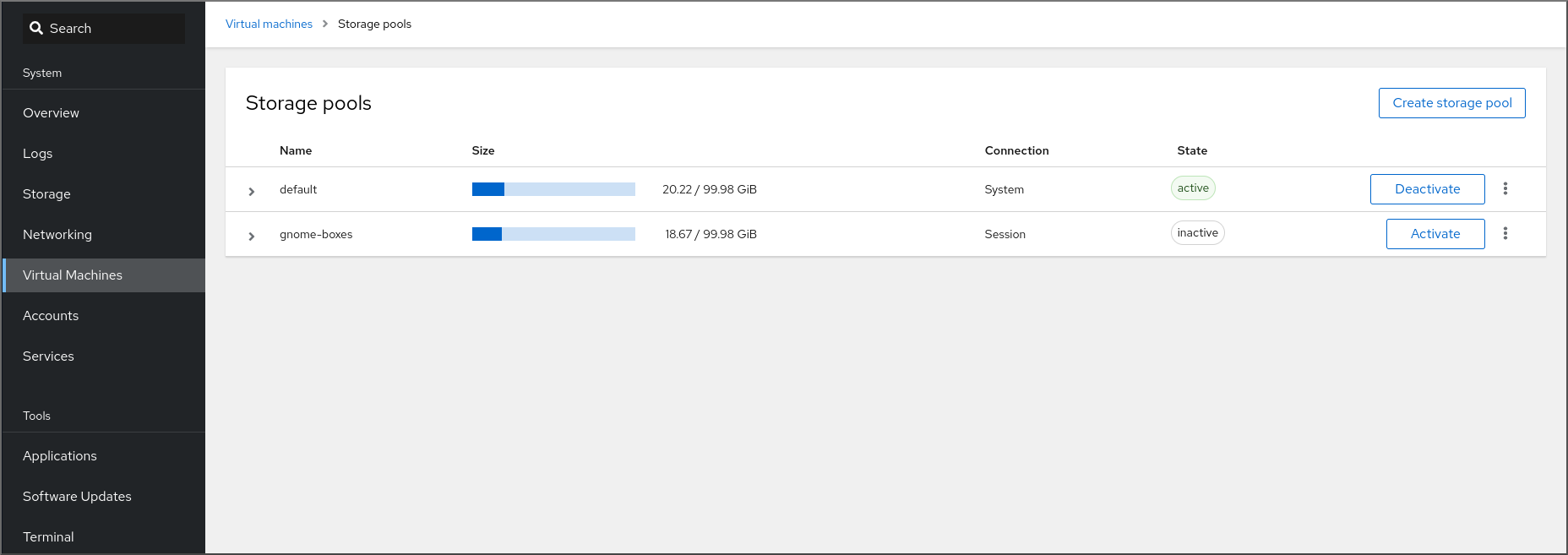

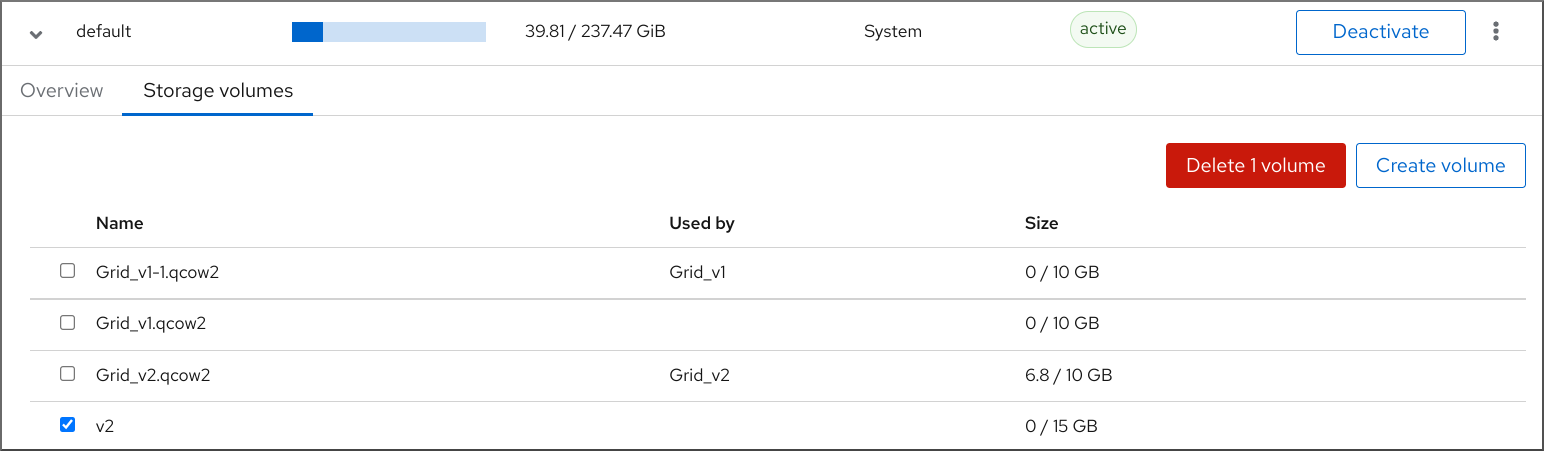

7.2.2. 使用 Web 控制台查看存储池信息

通过使用 Web 控制台,您可以查看系统上可用存储池的详细信息。存储池可用于为您的虚拟机创建磁盘映像。

先决条件

已安装 RHEL 8 web 控制台。

具体步骤请参阅安装并启用 Web 控制台。

- Web 控制台 VM 插件 已安装在您的系统上。

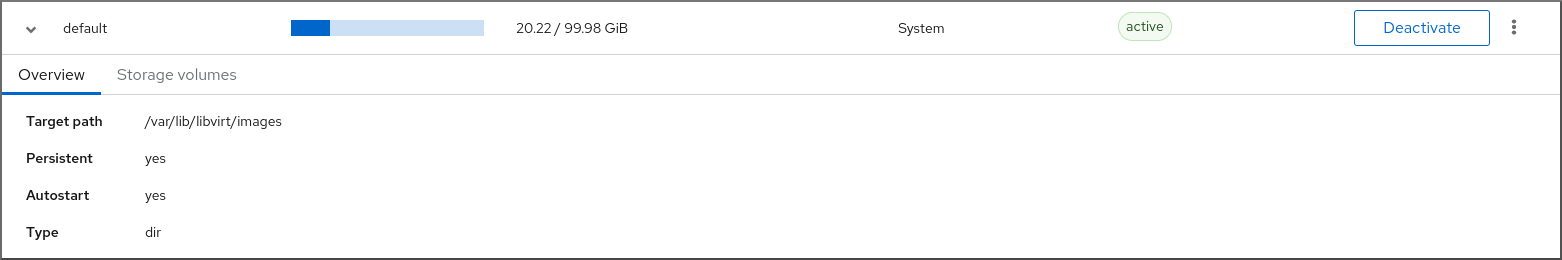

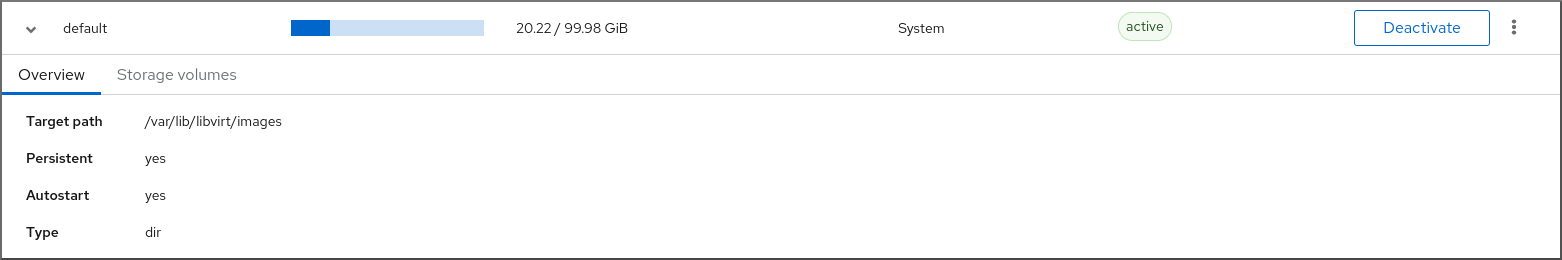

流程

登录到 RHEL 8 web 控制台。

详情请参阅 登录到 web 控制台。

点 接口顶部的 。

此时会出现 存储池 窗口,显示配置的存储池列表。

该信息包括:

- Name - 存储池的名称。

- Size - 当前分配和存储池的总容量。

- connection - 用于访问存储池的连接。

- State - 存储池的状态。

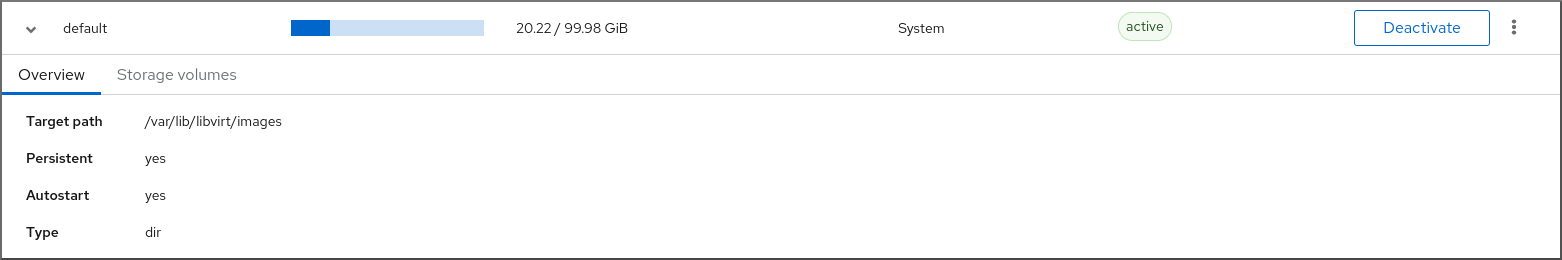

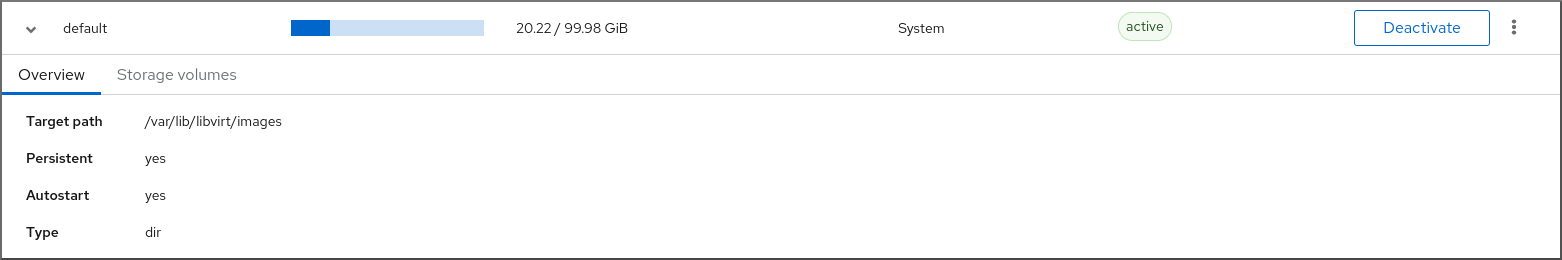

点击您要查看其信息的存储池旁的箭头。

行会展开,以显示概述窗格,其中含有所选存储池的详细信息。

该信息包括:

- 目标路径 - 存储池的位置。

- Persistent - 表示存储池是否具有持久性配置。

- Autostart - 表示在系统启动时存储池是否自动启动。

- 类型 - 存储池的类型。

要查看与存储池相关联的存储卷的列表,请单击 。

这时将出现存储卷窗格,显示已配置的存储卷的列表。

该信息包括:

- Name - 存储卷的名称。

- Used by - 当前使用存储卷的虚拟机。

- Size - 卷的大小。

其它资源

7.2.3. 在 web 控制台中查看基本虚拟机信息

通过使用 web 控制台,您可以查看有关所选虚拟机(VM)的基本信息,如分配的资源或虚拟机监控程序详情。

先决条件

- Web 控制台 VM 插件 已安装在您的系统上。

流程

登录到 RHEL 8 web 控制台。

详情请参阅 登录到 web 控制台。

- 在 web 控制台侧菜单中点击 。

点击您要查看其信息的虚拟机。

此时将打开一个新页面,其中包含关于所选虚拟机基本信息的概述部分,以及用于访问虚拟机的图形界面的控制台部分。

概述部分包括以下常规虚拟机详情:

- State - VM 的状态,运行或关闭。

- Memory - 分配给虚拟机的内存量。

- CPU - 为虚拟机配置的虚拟 CPU 的数量和类型。

- Boot Order - 为虚拟机配置的引导顺序。

- Autostart - 是否为虚拟机启用自动启动。

该信息还包括以下管理程序详情:

- Emulated Machine - 虚拟机模拟的机器类型。

- Firmware - 虚拟机的固件。

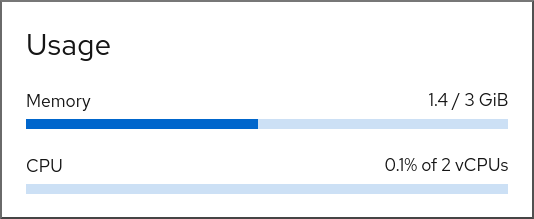

7.2.4. 在 web 控制台中查看虚拟机资源使用情况

通过使用 web 控制台,您可以查看所选虚拟机(VM)的内存和虚拟 CPU 用量。

先决条件

已安装 RHEL 8 web 控制台。

具体步骤请参阅安装并启用 Web 控制台。

- Web 控制台 VM 插件 已安装在您的系统上。

流程

登录到 RHEL 8 web 控制台。

详情请参阅 登录到 web 控制台。

在 界面中,点击您要查看其信息的虚拟机。

此时将打开一个新页面,其中包含关于所选虚拟机基本信息的概述部分,以及用于访问虚拟机的图形界面的控制台部分。

滚动到 。

使用情况部分显示有关虚拟机内存和虚拟 CPU 使用情况的信息。

其它资源

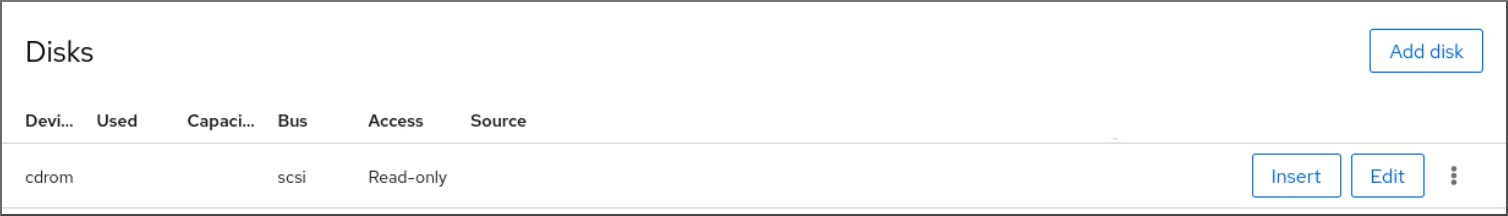

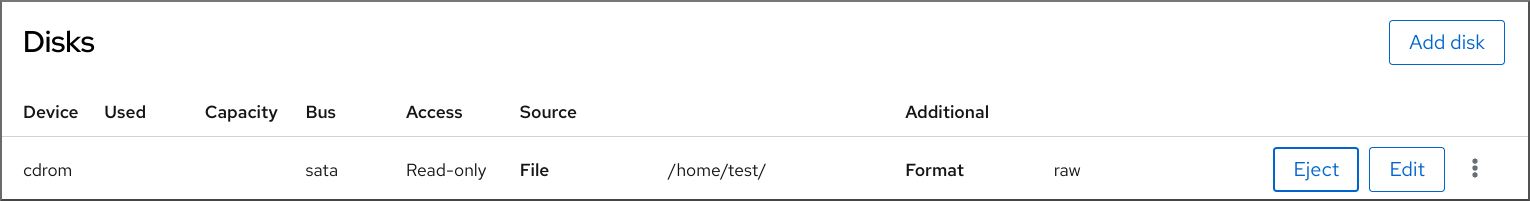

7.2.5. 在 web 控制台中查看虚拟机磁盘信息

通过使用 web 控制台,您可以查看分配给所选虚拟机(VM)的磁盘的详细信息。

先决条件

已安装 RHEL 8 web 控制台。

具体步骤请参阅安装并启用 Web 控制台。

- Web 控制台 VM 插件 已安装在您的系统上。

流程

登录到 RHEL 8 web 控制台。

详情请参阅 登录到 web 控制台。

点击您要查看其信息的虚拟机。

此时将打开一个新页面,其中包含关于所选虚拟机基本信息的概述部分,以及用于访问虚拟机的图形界面的控制台部分。

滚动到 。

Disks 部分显示分配给虚拟机的磁盘的信息,以及用于 添加或编辑磁盘 的选项。

该信息包括:

- Device - 磁盘的设备类型。

- Used - 当前分配的磁盘数量。

- Capacity - 存储卷的最大大小。

- Bus - 模拟的磁盘设备的类型。

-

Access - 磁盘是否是 可写 或 只读。对于

raw磁盘,您还可以将访问权限设为 可写和共享。 - Source - 磁盘设备或者文件。

其它资源

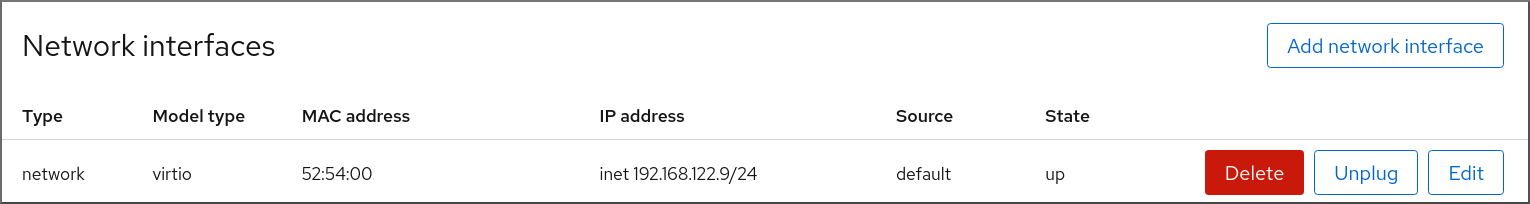

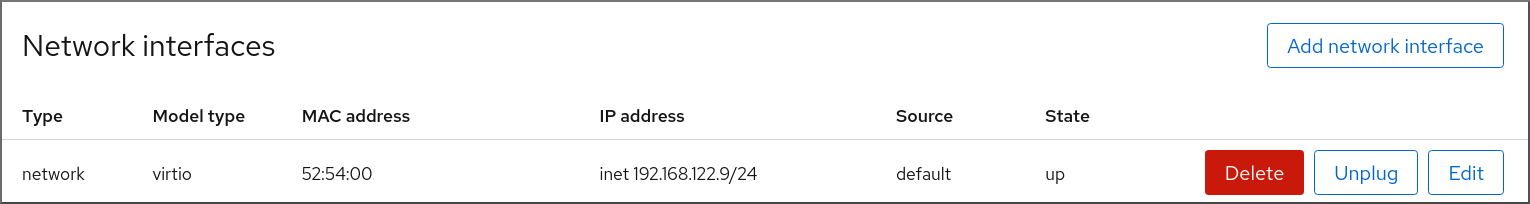

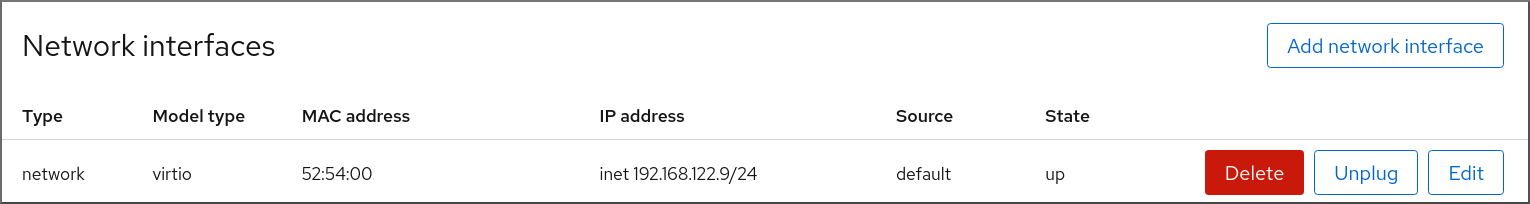

7.2.6. 在 web 控制台中查看和编辑虚拟网络接口信息

通过使用 RHEL 8 web 控制台,您可以在所选虚拟机(VM)上查看和修改虚拟网络接口:

先决条件

已安装 RHEL 8 web 控制台。

具体步骤请参阅安装并启用 Web 控制台。

- Web 控制台 VM 插件 已安装在您的系统上。

流程

登录到 RHEL 8 web 控制台。

详情请参阅 登录到 web 控制台。

在 界面中,点击您要查看其信息的虚拟机。

此时将打开一个新页面,其中包含关于所选虚拟机基本信息的概述部分,以及用于访问虚拟机的图形界面的控制台部分。

滚动 。

网络接口部分显示为虚拟机配置的虚拟网络接口的信息,以及 添加、删除、编辑 或 拔掉 网络接口的选项。

该信息包括:

类型 - 虚拟机的网络接口类型。类型包括虚拟网络、到 LAN 的桥接和直接连接。

注意RHEL 8 及更新版本不支持通用以太网连接。

- 型号类型 - 虚拟网络接口的型号。

- MAC 地址 - 虚拟网络接口的 MAC 地址。

- IP 地址 - 虚拟网络接口的 IP 地址。

- Source - 网络接口源。这取决于网络类型。

- State - 虚拟网络接口的状态。

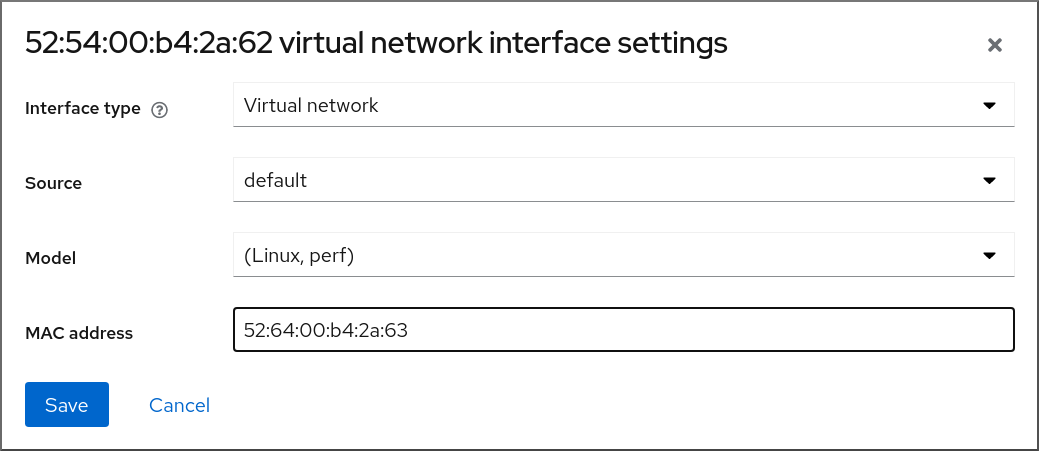

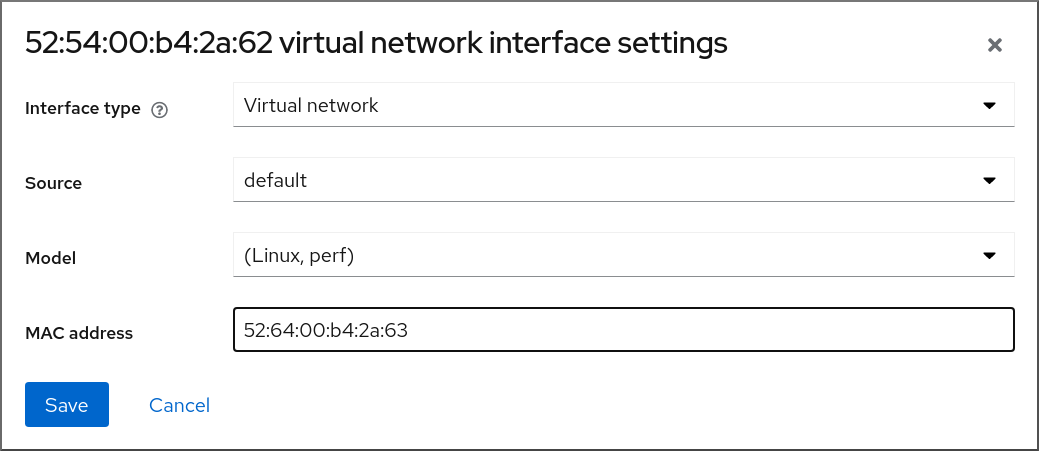

要编辑虚拟网络接口设置,请点 。此时会打开「虚拟网络接口设置」对话框。

- 更改接口类型、源、型号或 MAC 地址。

点 。已修改网络接口。

注意对虚拟网络接口设置的更改仅在重启虚拟机后生效。

此外,MAC 地址只能在虚拟机关闭时修改。

其它资源

7.3. 虚拟机 XML 配置示例

虚拟机的 XML 配置(也称为 域 XML )决定虚拟机的设置和组件。下表显示了虚拟机(VM)的 XML 配置示例并解释了其内容。

要获取虚拟机的 XML 配置,您可以使用 virsh dumpxml 命令,后跟虚拟机的名称。

# virsh dumpxml testguest1| 域 XML 部分 | 描述 |

|---|---|

<domain type='kvm'> <name>Testguest1</name> <uuid>ec6fbaa1-3eb4-49da-bf61-bb02fbec4967</uuid> <memory unit='KiB'>1048576</memory> <currentMemory unit='KiB'>1048576</currentMemory> | 这是一个名为 Testguest1 的 KVM 虚拟机,内存为 1024 MiB。 |

<vcpu placement='static'>1</vcpu> | 虚拟机被分配为单个虚拟 CPU(vCPU)。 有关配置 vCPU 的详情,请参考 优化虚拟机 CPU 性能。 |

<os> <type arch='x86_64' machine='pc-q35-4.1'>hvm</type> <boot dev='hd'/> </os> | 机器构架被设置为 AMD64 和 Intel 64 架构,并使用 Intel Q35 机器类型来决定功能兼容性。操作系统被设置为从硬盘引导。 有关使用安装的操作系统 创建虚拟机的详情,请参考 使用 web 控制台创建虚拟机并安装客户机操作系统。 |

<features> <acpi/> <apic/> </features> | acpi 和 apic hypervisor 功能被禁用。 |

<cpu mode='host-model' check='partial'/> |

功能 XML 中的主机 CPU 定义(可使用 |

<clock offset='utc'> <timer name='rtc' tickpolicy='catchup'/> <timer name='pit' tickpolicy='delay'/> <timer name='hpet' present='no'/> </clock> | VM 的虚拟硬件时钟使用 UTC 时区。另外,设置了三个不同的计时器以便与 QEMU 管理程序同步。 |

<on_poweroff>destroy</on_poweroff> <on_reboot>restart</on_reboot> <on_crash>destroy</on_crash> |

当虚拟机关闭或其操作系统意外终止时, |

<pm> <suspend-to-mem enabled='no'/> <suspend-to-disk enabled='no'/> </pm> | 这个虚拟机禁用 S3 和 S4 ACPI 睡眠状态。 |

<devices> <emulator>/usr/bin/qemu-kvm</emulator> <disk type='file' device='disk'> <driver name='qemu' type='qcow2'/> <source file='/var/lib/libvirt/images/Testguest.qcow2'/> <target dev='hda' bus='ide'/> </disk> <disk type='file' device='cdrom'> <driver name='qemu' type='raw'/> <target dev='hdb' bus='ide'/> <readonly/> </disk> |

虚拟机使用

第一个磁盘是基于主机上存储的

第二个磁盘是虚拟 CD-ROM,其逻辑设备名称设为 |

<controller type='usb' index='0' model='qemu-xhci' ports='15'/> <controller type='sata' index='0'/> <controller type='pci' index='0' model='pcie-root'/> <controller type='pci' index='1' model='pcie-root-port'> <model name='pcie-root-port'/> <target chassis='1' port='0x10'/> </controller> <controller type='pci' index='2' model='pcie-root-port'> <model name='pcie-root-port'/> <target chassis='2' port='0x11'/> </controller> <controller type='pci' index='3' model='pcie-root-port'> <model name='pcie-root-port'/> <target chassis='3' port='0x12'/> </controller> <controller type='pci' index='4' model='pcie-root-port'> <model name='pcie-root-port'/> <target chassis='4' port='0x13'/> </controller> <controller type='pci' index='5' model='pcie-root-port'> <model name='pcie-root-port'/> <target chassis='5' port='0x14'/> </controller> <controller type='pci' index='6' model='pcie-root-port'> <model name='pcie-root-port'/> <target chassis='6' port='0x15'/> </controller> <controller type='pci' index='7' model='pcie-root-port'> <model name='pcie-root-port'/> <target chassis='7' port='0x16'/> </controller> <controller type='virtio-serial' index='0'/> |

VM 使用单个控制器来附加 USB 设备,而用于 PCI-Express(PCIe)设备的根控制器。此外,提供了 有关虚拟设备的更多信息,请参阅 虚拟设备的类型。 |

<interface type='network'> <mac address='52:54:00:65:29:21'/> <source network='default'/> <model type='rtl8139'/> </interface> |

网络接口是在虚拟机中设置的,它使用 有关配置网络接口的详情,请参考 优化虚拟机网络性能。 |

<serial type='pty'>

<target type='isa-serial' port='0'>

<model name='isa-serial'/>

</target>

</serial>

<console type='pty'>

<target type='serial' port='0'/>

</console>

<channel type='unix'>

<target type='virtio' name='org.qemu.guest_agent.0'/>

<address type='virtio-serial' controller='0' bus='0' port='1'/>

</channel>

<channel type='spicevmc'>

<target type='virtio' name='com.redhat.spice.0'/>

<address type='virtio-serial' controller='0' bus='0' port='2'/>

</channel>

|

有关与虚拟机交互的更多信息,请参阅使用 web 控制台与虚拟机交互。 |

<input type='tablet' bus='usb'> <address type='usb' bus='0' port='1'/> </input> <input type='mouse' bus='ps2'/> <input type='keyboard' bus='ps2'/> | 虚拟机使用虚拟 usb 端口,该端口设定为接收表格输入,并设置了一个虚拟 ps2 端口以接收鼠标和键盘输入。这个设置是自动设置的,我们不推荐修改这些设置。 |

<graphics type='spice' autoport='yes' listen='127.0.0.1'> <listen type='address' address='127.0.0.1'/> <image compression='off'/> </graphics> <graphics type='vnc' port='-1' autoport='yes' listen='127.0.0.1'> <listen type='address' address='127.0.0.1'/> </graphics> |

虚拟机使用 |

<sound model='ich6'> <address type='pci' domain='0x0000' bus='0x00' slot='0x04' function='0x0'/> </sound> <video> <model type='qxl' ram='65536' vram='65536' vgamem='16384' heads='1' primary='yes'/> <address type='pci' domain='0x0000' bus='0x00' slot='0x02' function='0x0'/> </video> |

为虚拟机设置了 |

<redirdev bus='usb' type='spicevmc'> <address type='usb' bus='0' port='1'/> </redirdev> <redirdev bus='usb' type='spicevmc'> <address type='usb' bus='0' port='2'/> </redirdev> <memballoon model='virtio'> <address type='pci' domain='0x0000' bus='0x00' slot='0x07' function='0x0'/> </memballoon> </devices> </domain> | 虚拟机有两个重新目录来远程附加 USB 设备,打开内存 ballooning。这个设置是自动设置的,我们不推荐修改这些设置。 |

第 8 章 保存和恢复虚拟机

要释放系统资源,您可以关闭该系统中运行的虚拟机(VM)。然而,当您再次需要虚拟机时,您必须引导客户端操作系统(OS)并重启应用程序,这可能需要大量时间。要减少这个停机时间并让虚拟机工作负载更早开始运行,您可以使用保存和恢复功能来完全避免操作系统关闭和引导序列。

本节提供有关保存虚拟机的信息,以及在没有完全引导虚拟机的情况下将虚拟机恢复到同一状态的信息。

8.1. 保存和恢复虚拟机的工作方式

保存虚拟机(VM)会将其内存和设备状态保存到主机的磁盘中,并立即停止虚拟机进程。您可以保存处于运行状态或暂停状态的虚拟机,在恢复后,虚拟机将返回到那个状态。

这个过程释放了主机系统中的 RAM 和 CPU 资源以交换磁盘空间,这样可提高主机系统的性能。当虚拟机被恢复时,因为不需要引导客户机操作系统,也避免使用较长的启动周期。

要保存虚拟机,您可以使用命令行界面(CLI)。具体步骤请参阅 使用命令行界面保存虚拟机。

要恢复虚拟机,您可以使用 CLI 或 Web 控制台 GUI。

8.2. 使用命令行界面保存虚拟机

您可以将虚拟机(VM)及其当前状态保存到主机的磁盘上。这很有用,例如当您需要将主机的资源用于某些目的时。然后,保存的虚拟机可以快速恢复到其以前的运行状态。

要使用命令行保存虚拟机,请按照以下步骤操作。

先决条件

- 确定有足够的磁盘空间来保存虚拟机及其配置。请注意,虚拟机消耗的空间取决于分配给该虚拟机的 RAM 量。

- 确保虚拟机是持久的。

- 可选: 如果需要,从虚拟机备份重要数据。

流程

使用

virsh managedsave工具。例如,以下命令可停止 demo-guest1 虚拟机并保存其配置。

# virsh managedsave demo-guest1 Domain 'demo-guest1' saved by libvirt保存的虚拟机文件默认位于 /var/lib/libvirt/qemu/save 目录中,即 demo-guest1.save。

下次启动虚拟机时,它将自动从上述文件中恢复保存的状态。

验证

列出启用了 managed save 的虚拟机。在以下示例中,列为 saved 的虚拟机启用了 managed save 。

# virsh list --managed-save --all Id Name State ---------------------------------------------------- - demo-guest1 saved - demo-guest2 shut off列出具有受管保存镜像的虚拟机:

# virsh list --with-managed-save --all Id Name State ---------------------------------------------------- - demo-guest1 shut off请注意,要列出处于关机状态的保存的虚拟机,您必须使用命令的

--all或inactive选项。

故障排除

- 如果保存的虚拟机文件变得损坏或不可读,恢复虚拟机将启动标准虚拟机引导。

其它资源

-

virsh managedsave --help命令 - 使用命令行界面恢复保存的虚拟机

- 使用 Web 控制台恢复保存的虚拟机

8.3. 使用命令行界面启动虚拟机

您可以使用命令行界面(CLI)启动关闭的虚拟机(VM)或恢复保存的虚拟机。通过使用 CLI,您可以启动本地和远程虚拟机。

先决条件

- 已定义的一个不活跃地虚拟机。

- 虚拟机的名称。

对于远程虚拟机:

- 虚拟机所在主机的 IP 地址。

- 对主机的 root 访问权限。

流程

对于本地虚拟机,请使用

virsh start工具。例如,以下命令启动 demo-guest1 虚拟机。

# virsh start demo-guest1 Domain 'demo-guest1' started对于位于远程主机上的虚拟机,请使用

virsh start工具以及与主机的 QEMU+SSH 连接。例如,以下命令在 192.0.2.1 主机上启动 demo-guest1 虚拟机。

# virsh -c qemu+ssh://root@192.0.2.1/system start demo-guest1 root@192.0.2.1's password: Domain 'demo-guest1' started

其它资源

-

virsh start --help命令 - 设置对远程虚拟化主机的简单访问

- 当主机启动时自动启动虚拟机

8.4. 使用 web 控制台启动虚拟机

如果虚拟机(VM) 处于关闭状态,您可以使用 RHEL 8 web 控制台启动它。您还可以将虚拟机配置为在主机启动时自动启动。

先决条件

已安装 RHEL 8 web 控制台。

具体步骤请参阅安装并启用 Web 控制台。

- Web 控制台 VM 插件 已安装在您的系统上。

- 已定义的一个不活跃地虚拟机。

- 虚拟机的名称。

流程

在 界面中,点击您要启动的虚拟机。

此时将打开一个新页面,其中包含有关所选虚拟机的详细信息,以及关闭和删除虚拟机的控制。

点 。

虚拟机启动,您可以连接到其控制台或图形输出。

可选: 要将虚拟机配置为在主机启动时自动启动,请切换 Overview 部分中的

Autostart复选框。如果使用不由 libvirt 管理的网络接口,您还必须对 systemd 配置进行额外的更改。否则,受影响的虚拟机可能无法启动,请参阅 当主机启动时自动启动虚拟机。

第 9 章 克隆虚拟机

要使用特定属性集合快速创建新虚拟机,您可以克隆现有虚拟机。

克隆会创建一个使用其自身磁盘镜像保存存储的新虚拟机,但大多数克隆的配置和源虚拟机的数据都是一样的。这样就可以为特定的任务准备多个优化的虚拟机,而无需单独优化每一个虚拟机。

9.1. 克隆虚拟机的方式

克隆虚拟机会复制源虚拟机及其磁盘镜像的 XML 配置,并对配置进行修改以确保新虚拟机的唯一性。这包括更改虚拟机的名称,并确保它使用磁盘镜像克隆。存储在克隆的虚拟磁盘上的数据与源虚拟机是一致的。

这个过程比创建新虚拟机要快,并使用客户端操作系统安装它,并可用于快速生成带有特定配置和内容的虚拟机。

如果您计划为虚拟机创建多个克隆,首先请创建一个不包含以下内容的虚拟机模板:

- 唯一设置,如持久性网络 MAC 配置,这可阻止克隆正常工作。

- 敏感数据,如 SSH 密钥和密码文件。

具体说明请参阅 创建虚拟机模板。

9.2. 创建虚拟机模板

要创建可正常工作的多个虚拟机(VM)克隆,您可以对删除源虚拟机的唯一信息和配置,如 SSH 密钥或持久性网络 MAC 配置。这将创建一个虚拟机 模板,您可以使用它来轻松且安全地创建虚拟机克隆。

您可以使用 virt-sysprep 工具 创建虚拟机模板,或者根据您的要求 手动创建它们。

9.2.1. 使用 virt-sysprep 创建虚拟机模板

要从现有虚拟机(VM)创建克隆模板,您可以使用 virt-sysprep 工具。这会删除可能导致克隆正常工作的某些配置,如特定网络设置或系统注册元数据。因此,virt-sysprep 提高了虚拟机的克隆,并确保克隆更可靠。

先决条件

libguestfs-tools-c软件包(其包含virt-sysprep工具)已安装在您的主机上:# yum install libguestfs-tools-c- 作为模板的源虚拟机将被关闭。

您知道源虚拟机的磁盘镜像所处的位置,并且您是虚拟机磁盘镜像文件的所有者。

请注意,在 libvirt 系统连接 中创建的虚拟机的磁盘镜像位于

/var/lib/libvirt/images目录中,默认由 root 用户拥有:# ls -la /var/lib/libvirt/images -rw-------. 1 root root 9665380352 Jul 23 14:50 a-really-important-vm.qcow2 -rw-------. 1 root root 8591507456 Jul 26 2017 an-actual-vm-that-i-use.qcow2 -rw-------. 1 root root 8591507456 Jul 26 2017 totally-not-a-fake-vm.qcow2 -rw-------. 1 root root 10739318784 Sep 20 17:57 another-vm-example.qcow2- 可选:源虚拟机磁盘上的任何重要数据都已备份。如果要保留源虚拟机,请首先克隆它,并将克隆转换为模板。???

流程

确保您已作为虚拟机磁盘镜像的所有者登录:

# whoami root可选:复制虚拟机的磁盘镜像。

# cp /var/lib/libvirt/images/a-really-important-vm.qcow2 /var/lib/libvirt/images/a-really-important-vm-original.qcow2这用于验证虚拟机是否已成功转换为模板。

使用以下命令,将 /var/lib/libvirt/images/a-really-important-vm.qcow2 替换为源虚拟机磁盘镜像的路径。

# virt-sysprep -a /var/lib/libvirt/images/a-really-important-vm.qcow2 [ 0.0] Examining the guest ... [ 7.3] Performing "abrt-data" ... [ 7.3] Performing "backup-files" ... [ 9.6] Performing "bash-history" ... [ 9.6] Performing "blkid-tab" ... [...]

验证

要确认进程成功,请将修改的磁盘镜像与原始镜像进行比较。以下示例显示了成功创建模板:

# virt-diff -a /var/lib/libvirt/images/a-really-important-vm-orig.qcow2 -A /var/lib/libvirt/images/a-really-important-vm.qcow2 - - 0644 1001 /etc/group- - - 0000 797 /etc/gshadow- = - 0444 33 /etc/machine-id [...] - - 0600 409 /home/username/.bash_history - d 0700 6 /home/username/.ssh - - 0600 868 /root/.bash_history [...]

其它资源

-

您系统的

virt-sysprepman page 中的 OPERATIONS 部分 - 使用命令行界面克隆虚拟机

9.2.2. 手动创建虚拟机模板

要从现有虚拟机(VM)创建模板,您可以手动重置或取消配置客户虚拟机来为克隆做好准备。

先决条件

确保您知道源虚拟机的磁盘镜像的位置,并且是虚拟机磁盘镜像文件的所有者。

请注意,在 libvirt 的 系统连接 中创建的虚拟机的磁盘镜像默认位于

/var/lib/libvirt/images目录中,并由 root 用户拥有:# ls -la /var/lib/libvirt/images -rw-------. 1 root root 9665380352 Jul 23 14:50 a-really-important-vm.qcow2 -rw-------. 1 root root 8591507456 Jul 26 2017 an-actual-vm-that-i-use.qcow2 -rw-------. 1 root root 8591507456 Jul 26 2017 totally-not-a-fake-vm.qcow2 -rw-------. 1 root root 10739318784 Sep 20 17:57 another-vm-example.qcow2- 确保虚拟机已关闭。

- 可选:虚拟机磁盘上的任何重要数据都已备份。如果要保留源虚拟机,请首先 克隆它,并编辑克隆以创建模板。

流程

配置虚拟机以进行克隆:

- 在克隆上安装任何所需的软件。

- 为操作系统配置任何非唯一的设置。

- 配置任何非唯一的应用设置。

删除网络配置:

使用以下命令删除任何持久性 udev 规则:

# rm -f /etc/udev/rules.d/70-persistent-net.rules注意如果没有删除 udev 规则,第一个 NIC 的名称可能是

eth1而不是eth0。通过编辑

/etc/sysconfig/network-scripts/ifcfg-eth[x]来从 ifcfg 脚本中删除唯一的网络详情,如下所示:删除 HWADDR 和 Static 行:

注意如果 HWADDR 与新客户机的 MAC 地址不匹配,则

ifcfg将被忽略。DEVICE=eth[x] BOOTPROTO=none ONBOOT=yes #NETWORK=192.0.2.0 <- REMOVE #NETMASK=255.255.255.0 <- REMOVE #IPADDR=192.0.2.1 <- REMOVE #HWADDR=xx:xx:xx:xx:xx <- REMOVE #USERCTL=no <- REMOVE # Remove any other *unique or non-desired settings, such as UUID.*配置 DHCP,但不包含 HWADDR 或任何其他唯一信息:

DEVICE=eth[x] BOOTPROTO=dhcp ONBOOT=yes

如果系统中存在以下文件,请确保这些文件也包含同样的内容:

-

/etc/sysconfig/networking/devices/ifcfg-eth[x] /etc/sysconfig/networking/profiles/default/ifcfg-eth[x]注意如果您已使用

NetworkManager或虚拟机的任何特殊设置,请确保从ifcfg脚本中删除任何其他唯一的信息。

-

删除注册详情:

对于在 Red Hat Network (RHN)上注册的虚拟机:

# rm /etc/sysconfig/rhn/systemid对于使用 Red Hat Subscription Manager (RHSM)注册的虚拟机:

如果您不打算使用原始虚拟机:

# subscription-manager unsubscribe --all # subscription-manager unregister # subscription-manager clean如果您打算使用原始虚拟机:

# subscription-manager clean注意原始 RHSM 配置文件保留您 ID 代码的门户中。克隆后,使用以下命令重新激活虚拟机上的 RHSM 注册:

# subscription-manager register --consumerid=71rd64fx-6216-4409-bf3a-e4b7c7bd8ac9

删除其他唯一的详情:

删除 SSH 公钥和私钥对:

# rm -rf /etc/ssh/ssh_host_example删除 LVM 设备的配置:

# rm /etc/lvm/devices/system.devices- 如果在多台计算机上运行,删除任何其他特定于应用程序的标识符或配置可能会导致冲突。

删除

gnome-initial-setup-done文件,将虚拟机配置为在下次引导时运行配置向导:# rm ~/.config/gnome-initial-setup-done注意在下次引导时运行的向导依赖于已从虚拟机中删除的配置。另外,在克隆的第一次引导时,会建议您更改主机名。

9.3. 使用命令行界面克隆虚拟机

为了进行测试,要使用特定属性集创建新虚拟机,您可以使用 CLI 克隆现有虚拟机。

先决条件

- 源虚拟机被关闭。

- 确保有足够的磁盘空间来存储克隆的磁盘镜像。

- 可选: 在创建多个虚拟机克隆时,从源虚拟机中删除唯一数据和设置,以确保克隆的虚拟机正常工作。具体步骤请参阅创建虚拟机模板。

流程

使用

virt-clone工具以及适合您环境和用例的选项。使用案例示例

以下命令克隆一个名为

example-VM-1的本地虚拟机,并创建example-VM-1-clone虚拟机。它还会在与原始虚拟机的磁盘镜像相同的位置创建并分配example-VM-1-clone.qcow2磁盘镜像,并使用相同的数据:# virt-clone --original example-VM-1 --auto-clone Allocating 'example-VM-1-clone.qcow2' | 50.0 GB 00:05:37 Clone 'example-VM-1-clone' created successfully.以下命令克隆一个名为

example-VM-2的虚拟机,并创建一个名为example-VM-3的本地虚拟机,它只使用example-VM-2的多个磁盘中的两个:# virt-clone --original example-VM-2 --name example-VM-3 --file /var/lib/libvirt/images/disk-1-example-VM-2.qcow2 --file /var/lib/libvirt/images/disk-2-example-VM-2.qcow2 Allocating 'disk-1-example-VM-2-clone.qcow2' | 78.0 GB 00:05:37 Allocating 'disk-2-example-VM-2-clone.qcow2' | 80.0 GB 00:05:37 Clone 'example-VM-3' created successfully.要将虚拟机克隆到其他主机,请迁移虚拟机而无需在本地主机上取消它。例如,以下命令将之前创建的

example-VM-3虚拟机克隆到192.0.2.1远程系统,包括其本地磁盘。请注意,您需要 root 权限才能为192.0.2.1运行这些命令:# virsh migrate --offline --persistent example-VM-3 qemu+ssh://root@192.0.2.1/system root@192.0.2.1's password: # scp /var/lib/libvirt/images/<disk-1-example-VM-2-clone>.qcow2 root@192.0.2.1/<user@remote_host.com>://var/lib/libvirt/images/ # scp /var/lib/libvirt/images/<disk-2-example-VM-2-clone>.qcow2 root@192.0.2.1/<user@remote_host.com>://var/lib/libvirt/images/

验证

验证虚拟机是否已成功克隆,且正在正常工作:

确认克隆已添加到主机上的虚拟机列表中:

# virsh list --all Id Name State --------------------------------------- - example-VM-1 shut off - example-VM-1-clone shut off启动克隆并观察它是否引导起来了:

# virsh start example-VM-1-clone Domain 'example-VM-1-clone' started

其它资源

-

您系统上的

virt-clone (1)手册页 - 迁移虚拟机

9.4. 使用 web 控制台克隆虚拟机

要使用特定属性集创建新虚拟机,您可以克隆之前使用 web 控制台配置的虚拟机。

克隆虚拟机也会克隆与该虚拟机关联的磁盘。

先决条件

已安装 RHEL 8 web 控制台。

具体步骤请参阅安装并启用 Web 控制台。

- Web 控制台 VM 插件 已安装在您的系统上。

- 确保要克隆的虚拟机已关闭。

流程

登录到 RHEL 8 web 控制台。

详情请参阅 登录到 web 控制台。

在 web 控制台的虚拟机界面中,单击您要克隆的虚拟机的菜单按钮 。

此时会出现一个下拉菜单,控制各种虚拟机操作。

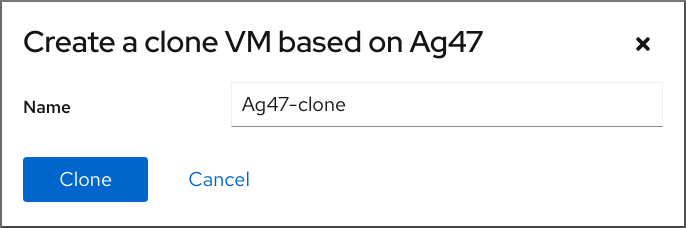

单击 。

此时将显示一个创建克隆虚拟机对话框。

- 可选:为虚拟机克隆输入新名称。

单击 。

基于源虚拟机的新虚拟机被创建。

验证

- 确认克隆的虚拟机是否出现在主机上可用的虚拟机列表中。

第 10 章 迁移虚拟机

如果虚拟机所在的当前主机变得不适合或者无法再使用,或者要重新分发托管工作负载,您可以将该虚拟机迁移到另一个 KVM 主机中。

10.1. 迁移虚拟机的工作方式

虚拟机迁移的基本部分是将虚拟机的 XML 配置复制到不同的主机机器中。如果没有关闭迁移的虚拟机,迁移还会将虚拟机内存和任何虚拟设备的状态传送到目标主机机器中。要使虚拟机在目标主机上正常工作,虚拟机的磁盘镜像必须仍可用。

默认情况下,迁移的虚拟机在目标主机上是临时的,虚拟机在源主机上仍然被定义。

您可以使用实时或 非实时迁移 来迁移正在运行的虚拟机。要迁移关闭虚拟机,必须使用离线迁移。详情请查看下表。

| 迁移类型 | 描述 | 使用案例 | 存储要求 |

|---|---|---|---|

| 实时迁移 | VM 将继续在源主机中运行,而 KVM 会将虚拟机的内存页面传送到目标主机。当迁移接近完成后,KVM 会非常简单地挂起虚拟机,并在目标主机上恢复它。 | 对于需要一直保持运行的虚拟机,这个方法非常有用。但是,如果虚拟机修改内存页面的速度比 KVM 可以传输它们的速度更快,比如 I/O 负载较重的虚拟机,则不能进行实时迁移,这需要使用非实时迁移。 | VM 的磁盘镜像必须可以被源主机和目标主机访问。(1) |

| 非实时迁移 | 挂起虚拟机,将其配置及其内存复制到目标主机,并恢复虚拟机。 | 这个迁移方式需要虚拟机停机,但通常比实时迁移更可靠。推荐用于内存负载较重的虚拟机。 | VM 的磁盘镜像必须可以被源主机和目标主机访问。(1) |

| 混合迁移 | 合并 实时迁移和非实时迁移 。您可以在实时迁移过程中挂起源虚拟机,这样可防止生成额外的脏内存页面。因此,迁移会更有可能完成。 | 建议您在实时迁移使用大量 vCPU 或大量内存的虚拟机时,这会阻止迁移完成。 根据客户机工作负载和迁移期间的静态页面数量,混合迁移可能比非实时迁移的停机时间要少得多。 | VM 的磁盘镜像必须可以被源主机和目标主机访问。(1) |

| 离线迁移 | 将虚拟机的配置移到目标主机 | 建议用于关闭虚拟机以及关闭虚拟机不会影响您工作负载的情况。 | VM 的磁盘镜像不必在共享网络中可用,并可手动复制或移动到目标主机。 |

(1)要达到此目的,请使用以下任一操作:

其它资源

10.2. 迁移虚拟机的好处

迁移虚拟机对以下情况非常有用:

- 负载均衡

- 如果主机超载或者另一台主机使用不足,则可将虚拟机移动到使用率较低的主机中。

- 硬件独立

- 当您需要升级、添加或删除主机中的硬件设备时,您可以安全地将虚拟机重新定位到其他主机。这意味着,在改进硬件时虚拟机不需要停机。

- 节能

- 虚拟机可重新分发到其他主机,因此可关闭未载入的主机系统以便在低用量时节约能源并降低成本。

- 地理迁移

- 可将虚拟机移动到另一个物理位置,以减少延迟,或者因为其他原因需要。

10.3. 迁移虚拟机的限制

在 RHEL 8 中迁移虚拟机(VM)前,请确保您了解迁移的限制。

- 实时存储迁移无法在 RHEL 8 上执行,但您可以在虚拟机关闭时迁移存储。请注意,红帽虚拟化 上提供了实时存储迁移。

-

将虚拟机从或迁移到

libvirt的会话连接 是不可靠的,因此不建议这样做。 使用以下功能和配置的虚拟机在迁移时将无法正常工作,或者迁移失败。这些特性包括:

- 设备透传

- SR-IOV 设备分配

- 介质设备,如 vGPU

- 使用非统一内存访问(NUMA)固定的主机之间的迁移只有在主机有类似的拓扑时才能正常工作。但是,迁移可能会对运行工作负载的性能造成负面影响。

源虚拟机和目标虚拟机上模拟的 CPU 必须相同,否则迁移可能会失败。虚拟机之间在以下 CPU 相关区域的任何区别都可能会引起迁移问题:

CPU 型号

- 不支持在 Intel 64 主机和 AMD64 主机之间迁移,即使它们共享 x86-64 指令集。

- 有关确保在迁移到具有不同 CPU 模型的主机后虚拟机可以正常工作的步骤,请参阅验证虚拟机迁移的主机 CPU 兼容性。

- 固件设置

- 微码版本

- BIOS 版本

- BIOS 设置

- QEMU 版本

- 内核版本

- 在某些情况下,实时迁移使用超过 1 TB 内存的虚拟机可能不可靠。有关如何防止或修复此问题的说明,请参阅 虚拟机的实时迁移花费了很长时间,而没有完成。

10.4. 验证虚拟机迁移的主机 CPU 兼容性

要使迁移的虚拟机(VM)在目标主机上正常工作,源和目标主机上的 CPU 必须兼容。要确保情况如此,请在开始迁移前计算一个常见 CPU 基准。

本节中的说明使用了具有以下主机 CPU 的迁移示例:

- 源主机:Intel Core i7-8650U

- 目标主机:Intel Xeon CPU E5-2620 v2

先决条件

- 已在您的系统中安装并启用虚拟化。

- 您具有对源主机和迁移的目标主机的管理员访问权限。

流程

在源主机上,获取其 CPU 功能并将其粘贴到新的 XML 文件中,如

domCaps-CPUs.xml。# virsh domcapabilities | xmllint --xpath "//cpu/mode[@name='host-model']" - > domCaps-CPUs.xml-

在 XML 文件中,将 <

mode> </mode> 标签替换为<cpu> </cpu>。 可选:验证

domCaps-CPUs.xml文件的内容类似如下:# cat domCaps-CPUs.xml <cpu> <model fallback="forbid">Skylake-Client-IBRS</model> <vendor>Intel</vendor> <feature policy="require" name="ss"/> <feature policy="require" name="vmx"/> <feature policy="require" name="pdcm"/> <feature policy="require" name="hypervisor"/> <feature policy="require" name="tsc_adjust"/> <feature policy="require" name="clflushopt"/> <feature policy="require" name="umip"/> <feature policy="require" name="md-clear"/> <feature policy="require" name="stibp"/> <feature policy="require" name="arch-capabilities"/> <feature policy="require" name="ssbd"/> <feature policy="require" name="xsaves"/> <feature policy="require" name="pdpe1gb"/> <feature policy="require" name="invtsc"/> <feature policy="require" name="ibpb"/> <feature policy="require" name="ibrs"/> <feature policy="require" name="amd-stibp"/> <feature policy="require" name="amd-ssbd"/> <feature policy="require" name="rsba"/> <feature policy="require" name="skip-l1dfl-vmentry"/> <feature policy="require" name="pschange-mc-no"/> <feature policy="disable" name="hle"/> <feature policy="disable" name="rtm"/> </cpu>在目标主机上,使用以下命令获取其 CPU 功能:

# virsh domcapabilities | xmllint --xpath "//cpu/mode[@name='host-model']" - <mode name="host-model" supported="yes"> <model fallback="forbid">IvyBridge-IBRS</model> <vendor>Intel</vendor> <feature policy="require" name="ss"/> <feature policy="require" name="vmx"/> <feature policy="require" name="pdcm"/> <feature policy="require" name="pcid"/> <feature policy="require" name="hypervisor"/> <feature policy="require" name="arat"/> <feature policy="require" name="tsc_adjust"/> <feature policy="require" name="umip"/> <feature policy="require" name="md-clear"/> <feature policy="require" name="stibp"/> <feature policy="require" name="arch-capabilities"/> <feature policy="require" name="ssbd"/> <feature policy="require" name="xsaveopt"/> <feature policy="require" name="pdpe1gb"/> <feature policy="require" name="invtsc"/> <feature policy="require" name="ibpb"/> <feature policy="require" name="amd-ssbd"/> <feature policy="require" name="skip-l1dfl-vmentry"/> <feature policy="require" name="pschange-mc-no"/> </mode>-

将从目标主机获取的 CPU 功能添加到源主机上的

domCaps-CPUs.xml文件。同样,将 <mode> </mode> 标签替换为<cpu> </cpu> 并保存文件。 可选:验证 XML 文件现在是否包含来自两个主机的 CPU 功能。

# cat domCaps-CPUs.xml <cpu> <model fallback="forbid">Skylake-Client-IBRS</model> <vendor>Intel</vendor> <feature policy="require" name="ss"/> <feature policy="require" name="vmx"/> <feature policy="require" name="pdcm"/> <feature policy="require" name="hypervisor"/> <feature policy="require" name="tsc_adjust"/> <feature policy="require" name="clflushopt"/> <feature policy="require" name="umip"/> <feature policy="require" name="md-clear"/> <feature policy="require" name="stibp"/> <feature policy="require" name="arch-capabilities"/> <feature policy="require" name="ssbd"/> <feature policy="require" name="xsaves"/> <feature policy="require" name="pdpe1gb"/> <feature policy="require" name="invtsc"/> <feature policy="require" name="ibpb"/> <feature policy="require" name="ibrs"/> <feature policy="require" name="amd-stibp"/> <feature policy="require" name="amd-ssbd"/> <feature policy="require" name="rsba"/> <feature policy="require" name="skip-l1dfl-vmentry"/> <feature policy="require" name="pschange-mc-no"/> <feature policy="disable" name="hle"/> <feature policy="disable" name="rtm"/> </cpu> <cpu> <model fallback="forbid">IvyBridge-IBRS</model> <vendor>Intel</vendor> <feature policy="require" name="ss"/> <feature policy="require" name="vmx"/> <feature policy="require" name="pdcm"/> <feature policy="require" name="pcid"/> <feature policy="require" name="hypervisor"/> <feature policy="require" name="arat"/> <feature policy="require" name="tsc_adjust"/> <feature policy="require" name="umip"/> <feature policy="require" name="md-clear"/> <feature policy="require" name="stibp"/> <feature policy="require" name="arch-capabilities"/> <feature policy="require" name="ssbd"/> <feature policy="require" name="xsaveopt"/> <feature policy="require" name="pdpe1gb"/> <feature policy="require" name="invtsc"/> <feature policy="require" name="ibpb"/> <feature policy="require" name="amd-ssbd"/> <feature policy="require" name="skip-l1dfl-vmentry"/> <feature policy="require" name="pschange-mc-no"/> </cpu>使用 XML 文件计算您要迁移的虚拟机的 CPU 功能基准。

# virsh hypervisor-cpu-baseline domCaps-CPUs.xml <cpu mode='custom' match='exact'> <model fallback='forbid'>IvyBridge-IBRS</model> <vendor>Intel</vendor> <feature policy='require' name='ss'/> <feature policy='require' name='vmx'/> <feature policy='require' name='pdcm'/> <feature policy='require' name='pcid'/> <feature policy='require' name='hypervisor'/> <feature policy='require' name='arat'/> <feature policy='require' name='tsc_adjust'/> <feature policy='require' name='umip'/> <feature policy='require' name='md-clear'/> <feature policy='require' name='stibp'/> <feature policy='require' name='arch-capabilities'/> <feature policy='require' name='ssbd'/> <feature policy='require' name='xsaveopt'/> <feature policy='require' name='pdpe1gb'/> <feature policy='require' name='invtsc'/> <feature policy='require' name='ibpb'/> <feature policy='require' name='amd-ssbd'/> <feature policy='require' name='skip-l1dfl-vmentry'/> <feature policy='require' name='pschange-mc-no'/> </cpu>打开您要迁移的虚拟机 XML 配置,并将 <

cpu> 部分的内容替换为上一步中获取的设置。# virsh edit VM-name如果虚拟机正在运行,请重新启动它。

# virsh reboot VM-name

10.5. 将虚拟机磁盘镜像与其他主机共享

要在 支持的 KVM 主机 之间执行虚拟机(VM)的实时迁移,还必须以一种方式迁移正在运行的虚拟机的存储,以便虚拟机在迁移过程中读取和写入存储。

执行此操作的一种方法是使用共享虚拟机存储。以下流程提供了使用 NFS 协议将本地存储的虚拟机镜像与源主机和目标主机共享的说明。

先决条件

- 旨在迁移的虚拟机被关闭。

- 可选:主机系统可用于托管不是源或目标主机的存储,但源和目标主机都可以通过网络访问它。这是共享存储的最佳解决方案,并被红帽推荐。

- 请确定 NFS 文件锁定没有被使用,因为在 KVM 中不支持它。

- 在源和目标主机上安装并启用 NFS 协议。查看

- 部署 NFS 服务器.

流程

连接到提供共享存储的主机。在本例中,它是

example-shared-storage主机:# ssh root@example-shared-storage root@example-shared-storage's password: Last login: Mon Sep 24 12:05:36 2019 root~#在保存磁盘镜像的源主机上创建一个目录,并将与迁移主机共享:

# mkdir /var/lib/libvirt/shared-images将虚拟机的磁盘镜像从源主机复制到新创建的目录。以下示例将虚拟机的磁盘镜像

example-disk-1复制到example-shared-storage主机的/var/lib/libvirt/shared-images/目录中:# scp /var/lib/libvirt/images/example-disk-1.qcow2 root@example-shared-storage:/var/lib/libvirt/shared-images/example-disk-1.qcow2在您要用于共享存储的主机上,将共享目录添加到

/etc/exports文件中。以下示例将/var/lib/libvirt/shared-images目录与example-source-machine和example-destination-machine主机共享:# /var/lib/libvirt/shared-images example-source-machine(rw,no_root_squash) example-destination-machine(rw,no\_root_squash)在源和目标主机上,将共享目录挂载到

/var/lib/libvirt/images目录中:# mount example-shared-storage:/var/lib/libvirt/shared-images /var/lib/libvirt/images

验证

- 在源主机上启动虚拟机,并观察它是否成功引导。

其它资源

10.6. 使用命令行界面迁移虚拟机

如果虚拟机所在的当前主机变得不适合或者无法再使用,或者要重新分发托管工作负载,您可以将该虚拟机迁移到另一个 KVM 主机中。以下流程提供了对此类迁移的各种场景的说明和示例。

先决条件

- 源主机和目标主机都使用 KVM 管理程序。

-

源主机和目标主机可以通过网络相互访问。使用

ping工具进行验证。 确保目标主机上打开了以下端口:

- 使用 SSH 连接到目标主机需要端口 22。

- 使用 TLS 连接到目标主机需要端口 16509。

- 使用 TCP 连接到目标主机需要端口 16514。

- QEMU 需要端口 49152-49215 来传输内存和磁盘迁移数据。

- 对于红帽支持的迁移,源主机和目标主机必须使用特定的操作系统和机器类型。要确保情况是这种情况,请查看 支持的虚拟机迁移主机。

- 虚拟机必须与目标主机的 CPU 功能兼容。要确保情况如此,请参阅验证虚拟机迁移的主机 CPU 兼容性。

源主机和目标主机都可以访问要迁移的虚拟机的磁盘镜像。这在离线迁移中是可选的,但在迁移运行的虚拟机时是必需的。为确保两个主机的存储可访问性,必须应用以下之一:

- 您使用存储区域网络(SAN)逻辑单元(LUN)。

- 您使用 Ceph 存储集群。

-

您已将虚拟机的磁盘镜像复制到目标主机,在迁移虚拟机时您将使用

--copy-storage-all参数。或者,您已创建了 与源虚拟机磁盘相同的格式和大小的磁盘镜像。 - 磁盘镜像位于单独的网络位置。有关设置这样的共享虚拟机存储的步骤,请参阅 与其他主机 共享虚拟机磁盘镜像。

迁移正在运行的虚拟机时,您的网络带宽必须高于虚拟机生成脏内存页面的速度。

要在开始实时迁移之前获取虚拟机的脏页面率,请执行以下操作:

监控虚拟机在短时间内的脏页面生成率。

# virsh domdirtyrate-calc example-VM 30在监控完成后,获取其结果:

# virsh domstats example-VM --dirtyrate Domain: 'example-VM' dirtyrate.calc_status=2 dirtyrate.calc_start_time=200942 dirtyrate.calc_period=30 dirtyrate.megabytes_per_second=2在本例中,VM 每秒会生成 2 MB 的脏内存页面。如果您不暂停虚拟机或降低其工作负载,那么在小于或等于 2 MB/秒带宽的网络中尝试实时迁移这样的虚拟机会导致实时迁移不会进行。

为确保实时迁移成功完成,红帽建议您的网络带宽要明显大于虚拟机的脏页面生成率。

注意calc_period选项的值可能因工作负载和脏页率而异。您可以使用多个calc_period值进行试验,以确定与您环境中脏页率一致的最合适的周期。

- 当迁移公共网桥中现有虚拟机时,源和目标主机必须位于同一网络中。否则,迁移后 VM 网络将无法正常工作。

确保

libvirtd服务启用并在运行。# systemctl enable --now libvirtd.service

流程

使用

virsh migrate命令,以及适合您迁移要求的选项。以下命令使用 SSH 隧道将

example-VM-1虚拟机从本地主机迁移到example-destination主机的系统连接。虚拟机在迁移过程中保持运行状态。# virsh migrate --persistent --live example-VM-1 qemu+ssh://example-destination/system以下命令可让您手动调整运行在本地主机上的

example-VM-2虚拟机的配置,然后将虚拟机迁移到example-destination主机。迁移的虚拟机将自动使用更新的配置。# virsh dumpxml --migratable example-VM-2 > example-VM-2.xml # vi example-VM-2.xml # virsh migrate --live --persistent --xml example-VM-2.xml example-VM-2 qemu+ssh://example-destination/system

当目标主机需要使用不同路径访问共享虚拟机存储或配置特定于目标主机的功能时,这个过程很有用。

以下命令从