ファイルシステムの管理

Red Hat Enterprise Linux 9 でのファイルシステムの作成、変更、管理

概要

Red Hat ドキュメントへのフィードバック (英語のみ)

Red Hat ドキュメントに関するご意見やご感想をお寄せください。また、改善点があればお知らせください。

Jira からのフィードバック送信 (アカウントが必要)

- Jira の Web サイトにログインします。

- 上部のナビゲーションバーで Create をクリックします。

- Summary フィールドにわかりやすいタイトルを入力します。

- Description フィールドに、ドキュメントの改善に関するご意見を記入してください。ドキュメントの該当部分へのリンクも追加してください。

- ダイアログの下部にある Create をクリックします。

第1章 利用可能なファイルシステムの概要

利用可能な選択肢と、関連するトレードオフが多数あるため、アプリケーションに適したファイルシステムを選択することが重要になります。

次のセクションでは、Red Hat Enterprise Linux 9 にデフォルトで含まれるファイルシステムと、アプリケーションに最適なファイルシステムに関する推奨事項を説明します。

1.1. ファイルシステムの種類

Red Hat Enterprise Linux 9 は、さまざまなファイルシステム (FS) に対応します。さまざまな種類のファイルシステムがさまざまな問題を解決し、その使用はアプリケーションによって異なります。最も一般的なレベルでは、利用可能なファイルシステムを以下の主要なタイプにまとめることができます。

| タイプ | ファイルシステム | 属性とユースケース |

|---|---|---|

| ディスクまたはローカルのファイルシステム | XFS | XFS は、RHEL におけるデフォルトファイルシステムです。Red Hat は、互換性や、パフォーマンスおいて稀に発生する難しい問題などの特別な理由がない限り、XFS をローカルファイルシステムとしてデプロイすることを推奨します。 |

| ext4 | 従来の ext2 および ext3 ファイルシステムから進化した ext4 には、Linux で馴染みやすいという利点があります。多くの場合、パフォーマンスでは XFS に匹敵します。ext4 ファイルシステムとファイルサイズのサポート制限は、XFS よりも小さくなっています。 | |

| ネットワーク、またはクライアント/サーバーのファイルシステム | NFS | NFS は、同じネットワークにある複数のシステムでのファイル共有に使用します。 |

| SMB | SMB は、Microsoft Windows システムとのファイル共有に使用します。 | |

| 共有ストレージまたは共有ディスクのファイルシステム | GFS2 | GFS2 は、コンピュートクラスターのメンバーに共有書き込みアクセスを提供します。可能な限り、ローカルファイルシステムの機能的経験を備えた安定性と信頼性に重点が置かれています。SAS Grid、Tibco MQ、IBM Websphere MQ、および Red Hat Active MQ は、GFS2 に問題なくデプロイされています。 |

| ボリューム管理ファイルシステム | Stratis | Stratis は、XFS と LVM を組み合わせて構築されたボリュームマネージャーです。Stratis の目的は、Btrfs や ZFS などのボリューム管理ファイルシステムにより提供される機能をエミュレートすることです。このスタックを手動で構築することは可能ですが、Stratis は設定の複雑さを軽減し、ベストプラクティスを実装し、エラー情報を統合します。 |

1.2. ローカルファイルシステム

ローカルファイルシステムは、1 台のローカルサーバーで実行し、ストレージに直接接続されているファイルシステムです。

たとえば、ローカルファイルシステムは、内部 SATA ディスクまたは SAS ディスクにおける唯一の選択肢であり、ローカルドライブを備えた内蔵ハードウェア RAID コントローラーがサーバーにある場合に使用されます。ローカルファイルシステムは、SAN にエクスポートされたデバイスが共有されていない場合に、SAN が接続したストレージに最もよく使用されているファイルシステムです。

ローカルファイルシステムはすべて POSIX に準拠しており、サポートされているすべての Red Hat Enterprise Linux リリースと完全に互換性があります。POSIX 準拠のファイルシステムは、read()、write()、seek() など、明確に定義されたシステムコールのセットに対応します。

ファイルシステムの選択肢を検討するときは、必要なファイルシステムのサイズ、必要な固有の機能、実際の作業負荷下でのパフォーマンスに基づいてファイルシステムを選択してください。

- 利用可能なローカルファイルシステム

- XFS

- ext4

1.3. XFS ファイルシステム

XFS は、拡張性が高く、高性能で堅牢な、成熟した 64 ビットのジャーナリングファイルシステムで、1 台のホストで非常に大きなファイルおよびファイルシステムに対応します。Red Hat Enterprise Linux 9 ではデフォルトのファイルシステムになります。XFS は、元々 1990 年代の前半に SGI により開発され、極めて大規模なサーバーおよびストレージアレイで実行されてきた長い歴史があります。

XFS の機能は次のとおりです。

- 信頼性

- メタデータジャーナリング - システムの再起動時、およびファイルシステムの再マウント時に再生できるファイルシステム操作の記録を保持することで、システムクラッシュ後のファイルシステムの整合性を確保します。

- 広範囲に及ぶランタイムメタデータの整合性チェック

- 拡張性が高く、高速な修復ユーティリティー

- クォータジャーナリングクラッシュ後に行なわれる、時間がかかるクォータの整合性チェックが不要になります。

- スケーラビリティーおよびパフォーマンス

- 対応するファイルシステムのサイズが最大 1024 TiB

- 多数の同時操作に対応する機能

- 空き領域管理のスケーラビリティーに関する B-Tree インデックス

- 高度なメタデータ先読みアルゴリズム

- ストリーミングビデオのワークロードの最適化

- 割り当てスキーム

- エクステント (領域) ベースの割り当て

- ストライプを認識できる割り当てポリシー

- 遅延割り当て

- 領域の事前割り当て

- 動的に割り当てられる inode

- その他の機能

- Reflink ベースのファイルのコピー

- 密接に統合されたバックアップおよび復元のユーティリティー

- オンラインのデフラグ

- オンラインのファイルシステム拡張

- 包括的な診断機能

-

拡張属性 (

xattr)。これにより、システムが、ファイルごとに、名前と値の組み合わせを追加で関連付けられるようになります。 - プロジェクトまたはディレクトリーのクォータ。ディレクトリーツリー全体にクォータ制限を適用できます。

- サブセカンド (一秒未満) のタイムスタンプ

パフォーマンスの特徴

XFS は、エンタープライズレベルのワークロードがある大規模なシステムで優れたパフォーマンスを発揮します。大規模なシステムとは、相対的に CPU 数が多く、さらには複数の HBA、および外部ディスクアレイへの接続を備えたシステムです。XFS は、マルチスレッドの並列 I/O ワークロードを備えた小規模のシステムでも適切に実行します。

XFS は、シングルスレッドで、メタデータ集約型のワークロードのパフォーマンスが比較的低くなります。たとえば、シングルスレッドで小さなファイルを多数作成し、削除するワークロードがこれに当てはまります。

1.4. ext4 ファイルシステム

ext4 ファイルシステムは、ext ファイルシステムファミリーの第 4 世代です。これは、Red Hat Enterprise Linux 6 でデフォルトのファイルシステムです。

ext4 ドライバーは、ext2 および ext3 のファイルシステムの読み取りと書き込みが可能ですが、ext4 ファイルシステムのフォーマットは、ext2 ドライバーおよび ext3 ドライバーと互換性がありません。

ext4 には、以下のような新機能、および改善された機能が追加されました。

- 対応するファイルシステムのサイズが最大 50 TiB

- エクステントベースのメタデータ

- 遅延割り当て

- ジャーナルのチェックサム

- 大規模なストレージサポート

エクステントベースのメタデータと遅延割り当て機能は、ファイルシステムで使用されている領域を追跡する、よりコンパクトで効率的な方法を提供します。このような機能により、ファイルシステムのパフォーマンスが向上し、メタデータが使用する領域が低減します。遅延割り当てにより、ファイルシステムは、データがディスクにフラッシュされるまで、新しく書き込まれたユーザーデータの永続的な場所の選択を保留できます。これにより、より大きく、より連続した割り当てが可能になり、より優れた情報に基づいてファイルシステムが決定を下すことができるため、パフォーマンスが向上します。

ext4 で fsck ユーティリティーを使用するファイルシステムの修復時間は、ext2 と ext3 よりも高速です。一部のファイルシステムの修復では、最大 6 倍のパフォーマンスの向上が実証されています。

1.5. XFS と ext4 の比較

XFS は、RHEL におけるデフォルトファイルシステムです。このセクションでは、XFS および ext4 の使用方法と機能を比較します。

- メタデータエラーの動作

-

ext4 では、ファイルシステムがメタデータのエラーに遭遇した場合の動作を設定できます。デフォルトの動作では、操作を継続します。XFS が復旧できないメタデータエラーに遭遇すると、ファイルシステムをシャットダウンし、

EFSCORRUPTEDエラーを返します。 - クォータ

ext4 では、既存のファイルシステムにファイルシステムを作成する場合にクォータを有効にできます。次に、マウントオプションを使用してクォータの適用を設定できます。

XFS クォータは再マウントできるオプションではありません。初期マウントでクォータをアクティブにする必要があります。

XFS ファイルシステムで

quotacheckコマンドを実行すると影響しません。クォータアカウンティングを初めてオンにすると、XFS はクォータを自動的にチェックします。- ファイルシステムのサイズ変更

- XFS には、ファイルシステムのサイズを縮小するユーティリティーがありません。XFS ファイルシステムのサイズのみを増やすことができます。ext4 は、ファイルシステムの拡張と縮小の両方をサポートします。

- Inode 番号

ext4 ファイルシステムは、232 個を超える inode をサポートしません。

XFS は動的な inode 割り当てをサポートしています。XFS ファイルシステム上で inode が消費できる領域の量は、ファイルシステムの合計領域のパーセンテージとして計算されます。管理者は、システムの inode が不足するのを防ぐために、ファイルシステムの作成後にこのパーセンテージを調整できます (ファイルシステムに空き領域が残っている場合)。

特定のアプリケーションは、XFS ファイルシステムで 232 個を超える inode を適切に処理できません。このようなアプリケーションでは、戻り値

EOVERFLOWで 32 ビットの統計呼び出しに失敗する可能性があります。Inode 番号は、以下の条件下で 232 個を超えます。- ファイルシステムが 256 バイトの inode を持つ 1 TiB を超える。

- ファイルシステムが 512 バイトの inode を持つ 2 TiB を超える。

inode 番号が大きくてアプリケーションが失敗した場合は、

-o inode32オプションを使用して XFS ファイルシステムをマウントし、232 未満の inode 番号を実施します。inode32を使用しても、すでに 64 ビットの数値が割り当てられている inode には影響しません。重要特定の環境に必要な場合を除き、

inode32オプションは 使用しない でください。inode32オプションは割り当ての動作を変更します。これにより、下層のディスクブロックに inode を割り当てるための領域がない場合に、ENOSPCエラーが発生する可能性があります。

1.6. ローカルファイルシステムの選択

アプリケーション要件を満たすファイルシステムを選択するには、ファイルシステムをデプロイするターゲットシステムを理解する必要があります。一般的には、ext4 を特定の用途で使用する場合を除き、XFS を使用してください。

- XFS

- 大規模なデプロイメントの場合、特に大きなファイル (数百メガバイト) や大量の I/O 並行処理を扱う場合は、XFS を使用します。XFS は、高帯域幅 (200 MB/秒以上) および 1000 IOPS を超える環境で最適に動作します。ただし、ext4 と比較してメタデータ操作に多くの CPU リソースを消費します。また、ファイルシステムの縮小をサポートしていません。

- ext4

- 小規模なシステムや I/O 帯域幅が制限されている環境では、ext4 のほうが適している可能性があります。シングルスレッド、少量の I/O ワークロード、およびスループット要件が低い環境の場合は、パフォーマンスが向上します。また、ext4 はオフラインの縮小をサポートしています。これはファイルシステムのサイズ変更が必要な場合に役立ちます。

ターゲットサーバーとストレージシステムでアプリケーションのパフォーマンスをベンチマークし、選択したファイルシステムがパフォーマンスとスケーラビリティーの要件を満たしていることを確認してください。

| シナリオ | 推奨されるファイルシステム |

|---|---|

| 特別なユースケースなし | XFS |

| 大規模サーバー | XFS |

| 大規模なストレージデバイス | XFS |

| 大規模なファイル | XFS |

| マルチスレッド I/O | XFS |

| シングルスレッド I/O | ext4 |

| 制限された I/O 機能 (1000 IOPS 未満) | ext4 |

| 制限された帯域幅 (200MB/s 未満) | ext4 |

| CPU にバインドされているワークロード | ext4 |

| オフラインの縮小への対応 | ext4 |

1.7. ネットワークファイルシステム

クライアント/サーバーファイルシステムとも呼ばれるネットワークファイルシステムにより、クライアントシステムは、共有サーバーに保存されているファイルにアクセスできます。これにより、複数のシステムの、複数のユーザーが、ファイルやストレージリソースを共有できます。

このようなファイルシステムは、ファイルシステムのセットを 1 つ以上のクライアントにエクスポートする、1 つ以上のサーバーから構築されます。クライアントノードは、基盤となるブロックストレージにアクセスできませんが、より良いアクセス制御を可能にするプロトコルを使用してストレージと対話します。

- 利用可能なネットワークファイルシステム

- RHEL で最も一般的なクライアント/サーバーファイルシステムは、NFS ファイルシステムです。RHEL は、ネットワーク経由でローカルファイルシステムをエクスポートする NFS サーバーコンポーネントと、このようなファイルシステムをインポートする NFS クライアントの両方を提供します。

- RHEL には、Windows の相互運用性で一般的に使用されている Microsoft SMB ファイルサーバーに対応する CIFS クライアントも含まれています。ユーザー空間 Samba サーバーは、RHEL サーバーから Microsoft SMB サービスを使用する Windows クライアントを提供します。

1.10. ボリューム管理ファイルシステム

ボリューム管理ファイルシステムは、簡素化とスタック内の最適化の目的で、ストレージスタック全体を統合します。

- 利用可能なボリューム管理ファイルシステム

- Red Hat Enterprise Linux 9 は Stratis ボリュームマネージャーを提供します。Stratis は、ファイルシステム層に XFS を使用し、LVM、Device Mapper、およびその他のコンポーネントと統合します。

Stratis は、Red Hat Enterprise Linux 8.0 で初めてリリースされました。Red Hat が Btrfs を非推奨にした時に生じたギップを埋めると考えられています。Stratis 1.0 は、ユーザーによる複雑さを隠しつつ、重要なストレージ管理操作を実行できる直感的なコマンドラインベースのボリュームマネージャーです。

- ボリュームの管理

- プールの作成

- シンストレージプール

- スナップショット

- 自動化読み取りキャッシュ

Stratis は強力な機能を提供しますが、現時点では Btrfs や ZFS といったその他の製品と比較される可能性がある機能をいつくか欠いています。たとえば、セルフ修復を含む CRC には対応していません。

第2章 RHEL システムロールを使用したローカルストレージの管理

Ansible を使用して LVM とローカルファイルシステム (FS) を管理するには、RHEL 9 で使用可能な RHEL システムロールの 1 つである storage ロールを使用できます。

storage ロールを使用すると、ディスク上のファイルシステム、複数のマシンにある論理ボリューム、および RHEL 7.7 以降の全バージョンでのファイルシステムの管理を自動化できます。

RHEL システムロールと、その適用方法の詳細は、RHEL システムロールの概要 を参照してください。

2.1. storage RHEL システムロールを使用してブロックデバイスに XFS ファイルシステムを作成する

Ansible Playbook の例では、storage ロールを適用して、デフォルトのパラメーターを使用してブロックデバイス上に XFS ファイルシステムを作成します。

storage ロールは、パーティションが分割されていないディスク全体または論理ボリューム (LV) でのみファイルシステムを作成できます。パーティションにファイルシステムを作成することはできません。

前提条件

- コントロールノードと管理対象ノードの準備が完了している。

- 管理対象ノードで Playbook を実行できるユーザーとしてコントロールノードにログインしている。

-

管理対象ノードへの接続に使用するアカウントに、そのノードに対する

sudo権限がある。

手順

次の内容を含む Playbook ファイル (例:

~/playbook.yml) を作成します。--- - hosts: managed-node-01.example.com roles: - rhel-system-roles.storage vars: storage_volumes: - name: barefs type: disk disks: - sdb fs_type: xfs-

現在、ボリューム名 (この例では

barefs) は任意です。storageロールは、disks:属性にリスト表示されているディスクデバイスでボリュームを特定します。 -

XFS は RHEL 9 のデフォルトファイルシステムであるため、

fs_type: xfs行を省略することができます。 論理ボリュームにファイルシステムを作成するには、エンクロージングボリュームグループを含む

disks:属性の下に LVM 設定を指定します。詳細は、storage RHEL システムロールを使用して論理ボリュームを作成またはサイズ変更する を参照してください。LV デバイスへのパスを指定しないでください。

-

現在、ボリューム名 (この例では

Playbook の構文を検証します。

$ ansible-playbook --syntax-check ~/playbook.ymlこのコマンドは構文を検証するだけであり、有効だが不適切な設定から保護するものではないことに注意してください。

Playbook を実行します。

$ ansible-playbook ~/playbook.yml

関連情報

-

/usr/share/ansible/roles/rhel-system-roles.storage/README.mdファイル -

/usr/share/doc/rhel-system-roles/storage/ディレクトリー

2.2. storage RHEL システムロールを使用してファイルシステムを永続的にマウントする

Ansible の例では、storage ロールを適用して、XFS ファイルシステムを即時かつ永続的にマウントします。

前提条件

- コントロールノードと管理対象ノードの準備が完了している。

- 管理対象ノードで Playbook を実行できるユーザーとしてコントロールノードにログインしている。

-

管理対象ノードへの接続に使用するアカウントに、そのノードに対する

sudo権限がある。

手順

次の内容を含む Playbook ファイル (例:

~/playbook.yml) を作成します。--- - hosts: managed-node-01.example.com roles: - rhel-system-roles.storage vars: storage_volumes: - name: barefs type: disk disks: - sdb fs_type: xfs mount_point: /mnt/data mount_user: somebody mount_group: somegroup mount_mode: 0755-

この Playbook は、ファイルシステムを

/etc/fstabファイルに追加し、ファイルシステムを即座にマウントします。 -

/dev/sdbデバイス上のファイルシステム、またはマウントポイントのディレクトリーが存在しない場合は、Playbook により作成されます。

-

この Playbook は、ファイルシステムを

Playbook の構文を検証します。

$ ansible-playbook --syntax-check ~/playbook.ymlこのコマンドは構文を検証するだけであり、有効だが不適切な設定から保護するものではないことに注意してください。

Playbook を実行します。

$ ansible-playbook ~/playbook.yml

関連情報

-

/usr/share/ansible/roles/rhel-system-roles.storage/README.mdファイル -

/usr/share/doc/rhel-system-roles/storage/ディレクトリー

2.3. storage RHEL システムロールを使用して論理ボリュームを作成またはサイズ変更する

storage ロールを使用して、次のタスクを実行します。

- 多数のディスクで構成されるボリュームグループに LVM 論理ボリュームを作成する

- LVM 上の既存のファイルシステムのサイズを変更する

- LVM ボリュームのサイズをプールの合計サイズのパーセンテージで表す

ボリュームグループが存在しない場合、このロールによって作成されます。ボリュームグループ内に論理ボリュームが存在する場合に、そのサイズが Playbook で指定されたサイズと一致しないと、サイズが変更されます。

論理ボリュームを縮小する場合、データの損失を防ぐために、その論理ボリューム上のファイルシステムによって、縮小する論理ボリューム内の領域が使用されていないことを確認する必要があります。

前提条件

- コントロールノードと管理対象ノードの準備が完了している。

- 管理対象ノードで Playbook を実行できるユーザーとしてコントロールノードにログインしている。

-

管理対象ノードへの接続に使用するアカウントに、そのノードに対する

sudo権限がある。

手順

次の内容を含む Playbook ファイル (例:

~/playbook.yml) を作成します。--- - name: Manage local storage hosts: managed-node-01.example.com tasks: - name: Create logical volume ansible.builtin.include_role: name: rhel-system-roles.storage vars: storage_pools: - name: myvg disks: - sda - sdb - sdc volumes: - name: mylv size: 2G fs_type: ext4 mount_point: /mnt/dataサンプル Playbook で指定されている設定は次のとおりです。

size: <size>- 単位 (GiB など) またはパーセンテージ (60% など) を使用してサイズを指定する必要があります。

Playbook で使用されるすべての変数の詳細は、コントロールノードの

/usr/share/ansible/roles/rhel-system-roles.storage/README.mdファイルを参照してください。Playbook の構文を検証します。

$ ansible-playbook --syntax-check ~/playbook.ymlこのコマンドは構文を検証するだけであり、有効だが不適切な設定から保護するものではないことに注意してください。

Playbook を実行します。

$ ansible-playbook ~/playbook.yml

検証

指定したボリュームが作成されたこと、または要求したサイズに変更されたことを確認します。

# ansible managed-node-01.example.com -m command -a 'lvs myvg'

関連情報

-

/usr/share/ansible/roles/rhel-system-roles.storage/README.mdファイル -

/usr/share/doc/rhel-system-roles/storage/ディレクトリー

2.4. storage RHEL システムロールを使用してオンラインブロック破棄を有効にする

オンラインブロック破棄オプションを使用すると、XFS ファイルシステムをマウントし、未使用のブロックを自動的に破棄できます。

前提条件

- コントロールノードと管理対象ノードの準備が完了している。

- 管理対象ノードで Playbook を実行できるユーザーとしてコントロールノードにログインしている。

-

管理対象ノードへの接続に使用するアカウントに、そのノードに対する

sudo権限がある。

手順

次の内容を含む Playbook ファイル (例:

~/playbook.yml) を作成します。--- - name: Manage local storage hosts: managed-node-01.example.com tasks: - name: Enable online block discard ansible.builtin.include_role: name: rhel-system-roles.storage vars: storage_volumes: - name: barefs type: disk disks: - sdb fs_type: xfs mount_point: /mnt/data mount_options: discardPlaybook で使用されるすべての変数の詳細は、コントロールノードの

/usr/share/ansible/roles/rhel-system-roles.storage/README.mdファイルを参照してください。Playbook の構文を検証します。

$ ansible-playbook --syntax-check ~/playbook.ymlこのコマンドは構文を検証するだけであり、有効だが不適切な設定から保護するものではないことに注意してください。

Playbook を実行します。

$ ansible-playbook ~/playbook.yml

検証

オンラインブロック破棄オプションが有効になっていることを確認します。

# ansible managed-node-01.example.com -m command -a 'findmnt /mnt/data'

関連情報

-

/usr/share/ansible/roles/rhel-system-roles.storage/README.mdファイル -

/usr/share/doc/rhel-system-roles/storage/ディレクトリー

2.5. storage RHEL システムロールを使用して Ext4 ファイルシステムを作成およびマウントする

Ansible Playbook の例では、storage ロールを適用して、Ext4 ファイルシステムを作成してマウントします。

前提条件

- コントロールノードと管理対象ノードの準備が完了している。

- 管理対象ノードで Playbook を実行できるユーザーとしてコントロールノードにログインしている。

-

管理対象ノードへの接続に使用するアカウントに、そのノードに対する

sudo権限がある。

手順

次の内容を含む Playbook ファイル (例:

~/playbook.yml) を作成します。--- - hosts: managed-node-01.example.com roles: - rhel-system-roles.storage vars: storage_volumes: - name: barefs type: disk disks: - sdb fs_type: ext4 fs_label: label-name mount_point: /mnt/data-

この Playbook は、

/dev/sdbディスクにファイルシステムを作成します。 -

この Playbook は、ファイルシステムを

/mnt/dataディレクトリーに永続的にマウントします。 -

ファイルシステムのラベルは

label-nameです。

-

この Playbook は、

Playbook の構文を検証します。

$ ansible-playbook --syntax-check ~/playbook.ymlこのコマンドは構文を検証するだけであり、有効だが不適切な設定から保護するものではないことに注意してください。

Playbook を実行します。

$ ansible-playbook ~/playbook.yml

関連情報

-

/usr/share/ansible/roles/rhel-system-roles.storage/README.mdファイル -

/usr/share/doc/rhel-system-roles/storage/ディレクトリー

2.6. storage RHEL システムロールを使用して Ext3 ファイルシステムを作成およびマウントする

Ansible Playbook の例では、storage ロールを適用して Ext3 ファイルシステムを作成してマウントします。

前提条件

- コントロールノードと管理対象ノードの準備が完了している。

- 管理対象ノードで Playbook を実行できるユーザーとしてコントロールノードにログインしている。

-

管理対象ノードへの接続に使用するアカウントに、そのノードに対する

sudo権限がある。

手順

次の内容を含む Playbook ファイル (例:

~/playbook.yml) を作成します。--- - hosts: all roles: - rhel-system-roles.storage vars: storage_volumes: - name: barefs type: disk disks: - sdb fs_type: ext3 fs_label: label-name mount_point: /mnt/data mount_user: somebody mount_group: somegroup mount_mode: 0755-

この Playbook は、

/dev/sdbディスクにファイルシステムを作成します。 -

この Playbook は、ファイルシステムを

/mnt/dataディレクトリーに永続的にマウントします。 -

ファイルシステムのラベルは

label-nameです。

-

この Playbook は、

Playbook の構文を検証します。

$ ansible-playbook --syntax-check ~/playbook.ymlこのコマンドは構文を検証するだけであり、有効だが不適切な設定から保護するものではないことに注意してください。

Playbook を実行します。

$ ansible-playbook ~/playbook.yml

関連情報

-

/usr/share/ansible/roles/rhel-system-roles.storage/README.mdファイル -

/usr/share/doc/rhel-system-roles/storage/ディレクトリー

2.7. storage RHEL システムロールを使用してスワップボリュームを作成する

このセクションでは、Ansible Playbook の例を示します。この Playbook は、storage ロールを適用し、デフォルトのパラメーターを使用して、ブロックデバイスにスワップボリュームが存在しない場合は作成し、スワップボリュームがすでに存在する場合はそれを変更します。

前提条件

- コントロールノードと管理対象ノードの準備が完了している。

- 管理対象ノードで Playbook を実行できるユーザーとしてコントロールノードにログインしている。

-

管理対象ノードへの接続に使用するアカウントに、そのノードに対する

sudo権限がある。

手順

次の内容を含む Playbook ファイル (例:

~/playbook.yml) を作成します。--- - name: Create a disk device with swap hosts: managed-node-01.example.com roles: - rhel-system-roles.storage vars: storage_volumes: - name: swap_fs type: disk disks: - /dev/sdb size: 15 GiB fs_type: swap現在、ボリューム名 (この例では

swap_fs) は任意です。storageロールは、disks:属性にリスト表示されているディスクデバイスでボリュームを特定します。Playbook の構文を検証します。

$ ansible-playbook --syntax-check ~/playbook.ymlこのコマンドは構文を検証するだけであり、有効だが不適切な設定から保護するものではないことに注意してください。

Playbook を実行します。

$ ansible-playbook ~/playbook.yml

関連情報

-

/usr/share/ansible/roles/rhel-system-roles.storage/README.mdファイル -

/usr/share/doc/rhel-system-roles/storage/ディレクトリー

2.8. storage RHEL システムロールを使用した RAID ボリュームの設定

storage システムロールを使用すると、Red Hat Ansible Automation Platform と Ansible-Core を使用して RHEL に RAID ボリュームを設定できます。要件に合わせて RAID ボリュームを設定するためのパラメーターを使用して、Ansible Playbook を作成します。

特定の状況でデバイス名が変更する場合があります。たとえば、新しいディスクをシステムに追加するときなどです。したがって、データの損失を防ぐために、Playbook では永続的な命名属性を使用してください。永続的な命名属性の詳細は、永続的な命名属性 を参照してください。

前提条件

- コントロールノードと管理対象ノードの準備が完了している。

- 管理対象ノードで Playbook を実行できるユーザーとしてコントロールノードにログインしている。

-

管理対象ノードへの接続に使用するアカウントに、そのノードに対する

sudo権限がある。

手順

次の内容を含む Playbook ファイル (例:

~/playbook.yml) を作成します。--- - name: Manage local storage hosts: managed-node-01.example.com tasks: - name: Create a RAID on sdd, sde, sdf, and sdg ansible.builtin.include_role: name: rhel-system-roles.storage vars: storage_safe_mode: false storage_volumes: - name: data type: raid disks: [sdd, sde, sdf, sdg] raid_level: raid0 raid_chunk_size: 32 KiB mount_point: /mnt/data state: presentPlaybook で使用されるすべての変数の詳細は、コントロールノードの

/usr/share/ansible/roles/rhel-system-roles.storage/README.mdファイルを参照してください。Playbook の構文を検証します。

$ ansible-playbook --syntax-check ~/playbook.ymlこのコマンドは構文を検証するだけであり、有効だが不適切な設定から保護するものではないことに注意してください。

Playbook を実行します。

$ ansible-playbook ~/playbook.yml

検証

アレイが正しく作成されたことを確認します。

# ansible managed-node-01.example.com -m command -a 'mdadm --detail /dev/md/data'

関連情報

-

/usr/share/ansible/roles/rhel-system-roles.storage/README.mdファイル -

/usr/share/doc/rhel-system-roles/storage/ディレクトリー

2.9. storage RHEL システムロールを使用して RAID を備えた LVM プールを設定する

storage システムロールを使用すると、Red Hat Ansible Automation Platform を使用して、RAID を備えた LVM プールを RHEL に設定できます。利用可能なパラメーターを使用して Ansible Playbook を設定し、RAID を備えた LVM プールを設定できます。

前提条件

- コントロールノードと管理対象ノードの準備が完了している。

- 管理対象ノードで Playbook を実行できるユーザーとしてコントロールノードにログインしている。

-

管理対象ノードへの接続に使用するアカウントに、そのノードに対する

sudo権限がある。

手順

次の内容を含む Playbook ファイル (例:

~/playbook.yml) を作成します。--- - name: Manage local storage hosts: managed-node-01.example.com tasks: - name: Configure LVM pool with RAID ansible.builtin.include_role: name: rhel-system-roles.storage vars: storage_safe_mode: false storage_pools: - name: my_pool type: lvm disks: [sdh, sdi] raid_level: raid1 volumes: - name: my_volume size: "1 GiB" mount_point: "/mnt/app/shared" fs_type: xfs state: presentPlaybook で使用されるすべての変数の詳細は、コントロールノードの

/usr/share/ansible/roles/rhel-system-roles.storage/README.mdファイルを参照してください。Playbook の構文を検証します。

$ ansible-playbook --syntax-check ~/playbook.ymlこのコマンドは構文を検証するだけであり、有効だが不適切な設定から保護するものではないことに注意してください。

Playbook を実行します。

$ ansible-playbook ~/playbook.yml

検証

プールが RAID 上にあることを確認します。

# ansible managed-node-01.example.com -m command -a 'lsblk'

関連情報

-

/usr/share/ansible/roles/rhel-system-roles.storage/README.mdファイル -

/usr/share/doc/rhel-system-roles/storage/ディレクトリー - RAID の管理

2.10. storage RHEL システムロールを使用して RAID LVM ボリュームのストライプサイズを設定する

storage システムロールを使用すると、Red Hat Ansible Automation Platform を使用して、RHEL の RAID LVM ボリュームのストライプサイズを設定できます。利用可能なパラメーターを使用して Ansible Playbook を設定し、RAID を備えた LVM プールを設定できます。

前提条件

- コントロールノードと管理対象ノードの準備が完了している。

- 管理対象ノードで Playbook を実行できるユーザーとしてコントロールノードにログインしている。

-

管理対象ノードへの接続に使用するアカウントに、そのノードに対する

sudo権限がある。

手順

次の内容を含む Playbook ファイル (例:

~/playbook.yml) を作成します。--- - name: Manage local storage hosts: managed-node-01.example.com tasks: - name: Configure stripe size for RAID LVM volumes ansible.builtin.include_role: name: rhel-system-roles.storage vars: storage_safe_mode: false storage_pools: - name: my_pool type: lvm disks: [sdh, sdi] volumes: - name: my_volume size: "1 GiB" mount_point: "/mnt/app/shared" fs_type: xfs raid_level: raid0 raid_stripe_size: "256 KiB" state: presentPlaybook で使用されるすべての変数の詳細は、コントロールノードの

/usr/share/ansible/roles/rhel-system-roles.storage/README.mdファイルを参照してください。Playbook の構文を検証します。

$ ansible-playbook --syntax-check ~/playbook.ymlこのコマンドは構文を検証するだけであり、有効だが不適切な設定から保護するものではないことに注意してください。

Playbook を実行します。

$ ansible-playbook ~/playbook.yml

検証

ストライプサイズが必要なサイズに設定されていることを確認します。

# ansible managed-node-01.example.com -m command -a 'lvs -o+stripesize /dev/my_pool/my_volume'

関連情報

-

/usr/share/ansible/roles/rhel-system-roles.storage/README.mdファイル -

/usr/share/doc/rhel-system-roles/storage/ディレクトリー - RAID の管理

2.11. storage RHEL システムロールを使用して LVM-VDO ボリュームを設定する

storage RHEL システムロールを使用して、圧縮と重複排除を有効にした LVM 上の VDO ボリューム (LVM-VDO) を作成できます。

storage システムロールが LVM VDO を使用するため、プールごとに作成できるボリュームは 1 つだけです。

前提条件

- コントロールノードと管理対象ノードの準備が完了している。

- 管理対象ノードで Playbook を実行できるユーザーとしてコントロールノードにログインしている。

-

管理対象ノードへの接続に使用するアカウントに、そのノードに対する

sudo権限がある。

手順

次の内容を含む Playbook ファイル (例:

~/playbook.yml) を作成します。--- - name: Manage local storage hosts: managed-node-01.example.com tasks: - name: Create LVM-VDO volume under volume group 'myvg' ansible.builtin.include_role: name: rhel-system-roles.storage vars: storage_pools: - name: myvg disks: - /dev/sdb volumes: - name: mylv1 compression: true deduplication: true vdo_pool_size: 10 GiB size: 30 GiB mount_point: /mnt/app/sharedサンプル Playbook で指定されている設定は次のとおりです。

vdo_pool_size: <size>- デバイス上でボリュームが占める実際のサイズ。サイズは、10 GiB など、人間が判読できる形式で指定できます。単位を指定しない場合、デフォルトでバイト単位に設定されます。

size: <size>- VDO ボリュームの仮想サイズ。

Playbook で使用されるすべての変数の詳細は、コントロールノードの

/usr/share/ansible/roles/rhel-system-roles.storage/README.mdファイルを参照してください。Playbook の構文を検証します。

$ ansible-playbook --syntax-check ~/playbook.ymlこのコマンドは構文を検証するだけであり、有効だが不適切な設定から保護するものではないことに注意してください。

Playbook を実行します。

$ ansible-playbook ~/playbook.yml

検証

圧縮と重複排除の現在のステータスを表示します。

$ ansible managed-node-01.example.com -m command -a 'lvs -o+vdo_compression,vdo_compression_state,vdo_deduplication,vdo_index_state' LV VG Attr LSize Pool Origin Data% Meta% Move Log Cpy%Sync Convert VDOCompression VDOCompressionState VDODeduplication VDOIndexState mylv1 myvg vwi-a-v--- 3.00t vpool0 enabled online enabled online

関連情報

-

/usr/share/ansible/roles/rhel-system-roles.storage/README.mdファイル -

/usr/share/doc/rhel-system-roles/storage/ディレクトリー

2.12. storage RHEL システムロールを使用して LUKS2 暗号化ボリュームを作成する

storage ロールを使用し、Ansible Playbook を実行して、LUKS で暗号化されたボリュームを作成および設定できます。

前提条件

- コントロールノードと管理対象ノードの準備が完了している。

- 管理対象ノードで Playbook を実行できるユーザーとしてコントロールノードにログインしている。

-

管理対象ノードへの接続に使用するアカウントに、そのノードに対する

sudo権限がある。

手順

機密性の高い変数を暗号化されたファイルに保存します。

vault を作成します。

$ ansible-vault create vault.yml New Vault password: <vault_password> Confirm New Vault password: <vault_password>

ansible-vault createコマンドでエディターが開いたら、機密データを<key>: <value>形式で入力します。luks_password: <password>- 変更を保存して、エディターを閉じます。Ansible は vault 内のデータを暗号化します。

次の内容を含む Playbook ファイル (例:

~/playbook.yml) を作成します。--- - name: Manage local storage hosts: managed-node-01.example.com vars_files: - vault.yml tasks: - name: Create and configure a volume encrypted with LUKS ansible.builtin.include_role: name: rhel-system-roles.storage vars: storage_volumes: - name: barefs type: disk disks: - sdb fs_type: xfs fs_label: <label> mount_point: /mnt/data encryption: true encryption_password: "{{ luks_password }}"Playbook で使用されるすべての変数の詳細は、コントロールノードの

/usr/share/ansible/roles/rhel-system-roles.storage/README.mdファイルを参照してください。Playbook の構文を検証します。

$ ansible-playbook --ask-vault-pass --syntax-check ~/playbook.ymlこのコマンドは構文を検証するだけであり、有効だが不適切な設定から保護するものではないことに注意してください。

Playbook を実行します。

$ ansible-playbook --ask-vault-pass ~/playbook.yml

検証

LUKS 暗号化ボリュームの

luksUUID値を見つけます。# ansible managed-node-01.example.com -m command -a 'cryptsetup luksUUID /dev/sdb' 4e4e7970-1822-470e-b55a-e91efe5d0f5cボリュームの暗号化ステータスを表示します。

# ansible managed-node-01.example.com -m command -a 'cryptsetup status luks-4e4e7970-1822-470e-b55a-e91efe5d0f5c' /dev/mapper/luks-4e4e7970-1822-470e-b55a-e91efe5d0f5c is active and is in use. type: LUKS2 cipher: aes-xts-plain64 keysize: 512 bits key location: keyring device: /dev/sdb ...作成された LUKS 暗号化ボリュームを確認します。

# ansible managed-node-01.example.com -m command -a 'cryptsetup luksDump /dev/sdb' LUKS header information Version: 2 Epoch: 3 Metadata area: 16384 [bytes] Keyslots area: 16744448 [bytes] UUID: 4e4e7970-1822-470e-b55a-e91efe5d0f5c Label: (no label) Subsystem: (no subsystem) Flags: (no flags) Data segments: 0: crypt offset: 16777216 [bytes] length: (whole device) cipher: aes-xts-plain64 sector: 512 [bytes] ...

関連情報

-

/usr/share/ansible/roles/rhel-system-roles.storage/README.mdファイル -

/usr/share/doc/rhel-system-roles/storage/ディレクトリー - LUKS を使用したブロックデバイスの暗号化

- Ansible vault

2.14. storage RHEL システムロールを使用して物理ボリュームのサイズを変更する

storage システムロールを使用して、ホストの外部から基盤となるストレージまたはディスクのサイズを変更した後、LVM 物理ボリュームのサイズを変更できます。たとえば、仮想ディスクのサイズを増やした後、既存の LVM でさらに多くの領域を使用できます。

前提条件

- コントロールノードと管理対象ノードの準備が完了している。

- 管理対象ノードで Playbook を実行できるユーザーとしてコントロールノードにログインしている。

-

管理対象ノードへの接続に使用するアカウントに、そのノードに対する

sudo権限がある。 - 基盤となるブロックストレージのサイズを変更した。

手順

次の内容を含む Playbook ファイル (例:

~/playbook.yml) を作成します。--- - name: Manage local storage hosts: managed-node-01.example.com tasks: - name: Resize LVM PV size ansible.builtin.include_role: name: rhel-system-roles.storage vars: storage_pools: - name: myvg disks: ["sdf"] type: lvm grow_to_fill: truePlaybook で使用されるすべての変数の詳細は、コントロールノードの

/usr/share/ansible/roles/rhel-system-roles.storage/README.mdファイルを参照してください。Playbook の構文を検証します。

$ ansible-playbook --syntax-check ~/playbook.ymlこのコマンドは構文を検証するだけであり、有効だが不適切な設定から保護するものではないことに注意してください。

Playbook を実行します。

$ ansible-playbook ~/playbook.yml

検証

新しい物理ボリュームのサイズを表示します。

$ ansible managed-node-01.example.com -m command -a 'pvs' PV VG Fmt Attr PSize PFree /dev/sdf1 myvg lvm2 a-- 1,99g 1,99g

関連情報

-

/usr/share/ansible/roles/rhel-system-roles.storage/README.mdファイル -

/usr/share/doc/rhel-system-roles/storage/ディレクトリー

2.15. storage RHEL システムロールを使用して暗号化された Stratis プールを作成する

データを保護するために、storage RHEL システムロールを使用して暗号化された Stratis プールを作成できます。パスフレーズに加えて、暗号化方法として Clevis と Tang または TPM 保護を使用できます。

Stratis 暗号化はプール全体でのみ設定できます。

前提条件

- コントロールノードと管理対象ノードの準備が完了している。

- 管理対象ノードで Playbook を実行できるユーザーとしてコントロールノードにログインしている。

-

管理対象ノードへの接続に使用するアカウントに、そのノードに対する

sudo権限がある。

手順

機密性の高い変数を暗号化されたファイルに保存します。

vault を作成します。

$ ansible-vault create vault.yml New Vault password: <vault_password> Confirm New Vault password: <vault_password>

ansible-vault createコマンドでエディターが開いたら、機密データを<key>: <value>形式で入力します。luks_password: <password>- 変更を保存して、エディターを閉じます。Ansible は vault 内のデータを暗号化します。

次の内容を含む Playbook ファイル (例:

~/playbook.yml) を作成します。--- - name: Manage local storage hosts: managed-node-01.example.com vars_files: - vault.yml tasks: - name: Create a new encrypted Stratis pool with Clevis and Tang ansible.builtin.include_role: name: rhel-system-roles.storage vars: storage_pools: - name: mypool disks: - sdd - sde type: stratis encryption: true encryption_password: "{{ luks_password }}" encryption_clevis_pin: tang encryption_tang_url: tang-server.example.com:7500サンプル Playbook で指定されている設定は次のとおりです。

encryption_password- LUKS ボリュームのロックを解除するために使用するパスワードまたはパスフレーズ。

encryption_clevis_pin-

作成されたプールを暗号化するために使用できる Clevis の方式。

tangとtpm2を使用できます。 encryption_tang_url- Tang サーバーの URL。

Playbook で使用されるすべての変数の詳細は、コントロールノードの

/usr/share/ansible/roles/rhel-system-roles.storage/README.mdファイルを参照してください。Playbook の構文を検証します。

$ ansible-playbook --ask-vault-pass --syntax-check ~/playbook.ymlこのコマンドは構文を検証するだけであり、有効だが不適切な設定から保護するものではないことに注意してください。

Playbook を実行します。

$ ansible-playbook --ask-vault-pass ~/playbook.yml

検証

Clevis と Tang が設定された状態でプールが作成されたことを確認します。

$ ansible managed-node-01.example.com -m command -a 'sudo stratis report' ... "clevis_config": { "thp": "j-G4ddvdbVfxpnUbgxlpbe3KutSKmcHttILAtAkMTNA", "url": "tang-server.example.com:7500" }, "clevis_pin": "tang", "in_use": true, "key_description": "blivet-mypool",

関連情報

-

/usr/share/ansible/roles/rhel-system-roles.storage/README.mdファイル -

/usr/share/doc/rhel-system-roles/storage/ディレクトリー - Ansible vault

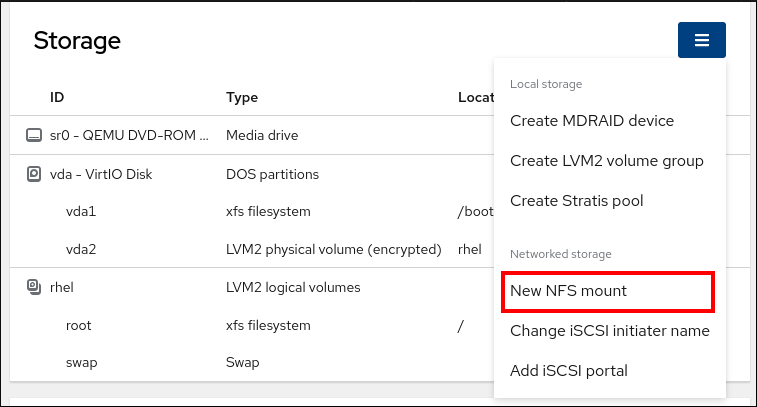

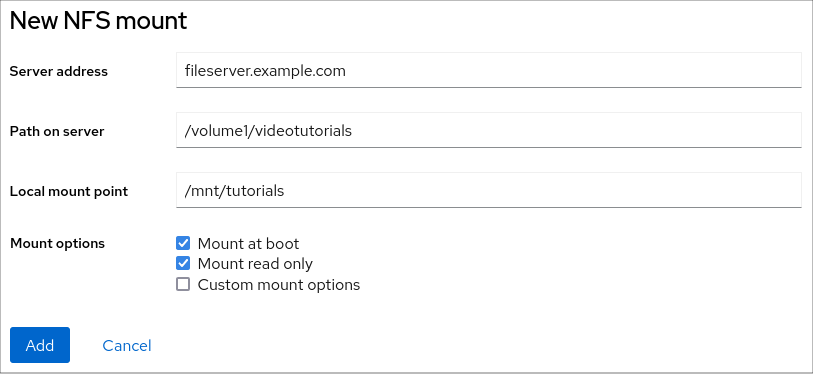

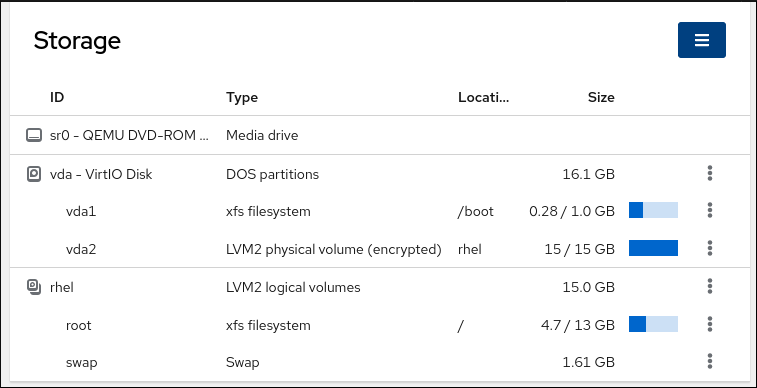

第3章 Web コンソールでパーティションの管理

Web コンソールを使用して、RHEL 9 でファイルシステムを管理する方法を説明します。

3.1. ファイルシステムでフォーマットされたパーティションを Web コンソールに表示

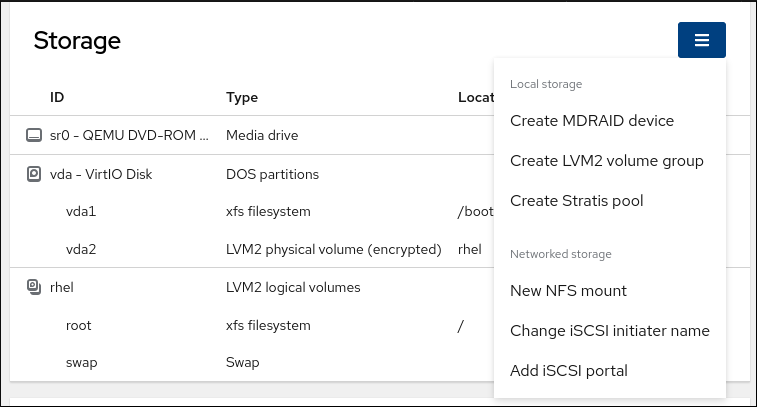

Web コンソールの ストレージ セクションには、ファイルシステム テーブルで使用可能なファイルシステムがすべて表示されます。

ファイルシステムでフォーマットされたパーティションのリストに加えて、新しいストレージを作成するためのページも使用できます。

前提条件

-

cockpit-storagedパッケージがシステムにインストールされている。

RHEL 9 Web コンソールがインストールされている。

手順は、Web コンソールのインストールおよび有効化 を参照してください。

手順

RHEL 9 Web コンソールにログインします。

詳細は、Web コンソールへのログイン を参照してください。

Storage タブをクリックします。

ストレージ テーブルでは、ファイルシステムでフォーマットされたすべての使用可能なパーティション、それらの ID、タイプ、場所、サイズ、および各パーティションで使用可能な容量を確認できます。

右上隅のドロップダウンメニューを使用して、新しいローカルストレージまたはネットワークストレージを作成することもできます。

3.2. Web コンソールでパーティションの作成

新しいパーティションを作成するには、以下を行います。

- 既存のパーティションテーブルを使用する

- パーティションを作成する

前提条件

-

cockpit-storagedパッケージがシステムにインストールされている。 - Web コンソールがインストールされており、アクセス可能である。詳細は、Web コンソールのインストール を参照してください。

- システムに接続されたフォーマットされていないボリュームは、Storage タブの Storage テーブルに表示されます。

手順

RHEL 9 Web コンソールにログインします。

詳細は、Web コンソールへのログイン を参照してください。

- Storage タブをクリックします。

- Storage テーブルで、パーティションを分割するデバイスをクリックして、そのデバイスのページとオプションを開きます。

- デバイスページで、メニューボタン をクリックし、Create partition table を選択します。

Initialize disk ダイアログボックスで、以下を選択します。

パーティション設定:

- すべてのシステムおよびデバイスと互換性あり (MBR)

- 最新のシステムおよび 2TB (GPT) 以上のハードディスクと互換性あり

- パーティションなし

オーバーライト:

RHEL Web コンソールでディスク全体をゼロで書き換える場合は、Overwrite existing data with zeros チェックボックスをオンにします。このプログラムはディスク全体を調べるため、このオプションを使用すると遅くなりますが、安全性は高まります。ディスクにデータが含まれていて、上書きする必要がある場合は、このオプションを使用します。

Overwrite existing data with zeros チェックボックスを選択しない場合、RHEL Web コンソールはディスクヘッダーのみを書き換えます。これにより、フォーマットの速度が向上します。

- をクリックします。

- 作成したパーティションテーブルの横にあるメニューボタン をクリックします。デフォルトでは Free space という名前が付けられます。

- をクリックします。

- Create partition ダイアログボックスで、ファイルシステムの Name を入力します。

- Mount point を追加します。

Type ドロップダウンメニューで、ファイルシステムを選択します。

- XFS ファイルシステムは大規模な論理ボリュームをサポートし、オンラインの物理ドライブを停止せずに、既存のファイルシステムの拡大および縮小を行うことができます。別のストレージの使用を希望しない場合は、このファイルシステムを選択したままにしてください。

ext4 ファイルシステムは以下に対応します。

- 論理ボリューム

- オンラインの物理ドライブを停止せずに切り替え

- ファイルシステムの拡張

- ファイルシステムの縮小

追加オプションは、LUKS (Linux Unified Key Setup) によって行われるパーティションの暗号化を有効にすることです。これにより、パスフレーズでボリュームを暗号化できます。

- 作成するボリュームの Size を入力します。

RHEL Web コンソールでディスク全体をゼロで書き換える場合は、Overwrite existing data with zeros チェックボックスをオンにします。このプログラムはディスク全体を調べるため、このオプションを使用すると遅くなりますが、安全性は高まります。ディスクにデータが含まれていて、上書きする必要がある場合は、このオプションを使用します。

Overwrite existing data with zeros チェックボックスを選択しない場合、RHEL Web コンソールはディスクヘッダーのみを書き換えます。これにより、フォーマットの速度が向上します。

ボリュームを暗号化する場合は、Encryption ドロップダウンメニューで暗号化の種類を選択します。

ボリュームを暗号化しない場合は、No encryption を選択します。

- At boot ドロップダウンメニューで、ボリュームをマウントするタイミングを選択します。

Mount options セクションで:

- ボリュームを読み取り専用論理ボリュームとしてマウントする場合は、Mount read only チェックボックスをオンにします。

- デフォルトのマウントオプションを変更する場合は、Custom mount options チェックボックスをオンにしてマウントオプションを追加します。

パーティションを作成します。

- パーティションを作成してマウントする場合は、 ボタンをクリックします。

パーティションのみを作成する場合は、 ボタンをクリックします。

ボリュームのサイズや、選択するオプションによって、フォーマットに数分かかることがあります。

検証

- パーティションが正常に追加されたことを確認するには、Storage タブに切り替えて Storage テーブルを確認し、新しいパーティションがリストされているかどうかを確認します。

3.3. Web コンソールでパーティションの削除

Web コンソールインターフェイスでパーティションを削除できます。

前提条件

-

cockpit-storagedパッケージがシステムにインストールされている。

RHEL 9 Web コンソールがインストールされている。

手順は、Web コンソールのインストールおよび有効化 を参照してください。

手順

RHEL 9 Web コンソールにログインします。

詳細は、Web コンソールへのログイン を参照してください。

- Storage タブをクリックします。

- パーティションを削除するデバイスをクリックします。

- デバイスページの GPT partitions セクションで、削除するパーティションの横にあるメニューボタン をクリックします。

ドロップダウンメニューから を選択します。

RHEL Web コンソールは、パーティションを削除する前に、現在パーティションを使用しているすべてのプロセスを終了し、パーティションをアンマウントします。

検証

- パーティションが正常に削除されたことを確認するには、ストレージ タブに切り替えて、コンテンツ テーブルを確認します。

第6章 永続的な命名属性の概要

システム管理者は、永続的な命名属性を使用してストレージボリュームを参照し、再起動を何度も行っても信頼できるストレージ設定を構築する必要があります。

6.1. 非永続的な命名属性のデメリット

Red Hat Enterprise Linux では、ストレージデバイスを識別する方法が複数あります。特にドライブへのインストール時やドライブの再フォーマット時に誤ったデバイスにアクセスしないようにするため、適切なオプションを使用して各デバイスを識別することが重要になります。

従来、/dev/sd(メジャー番号)(マイナー番号) の形式の非永続的な名前は、ストレージデバイスを参照するために Linux 上で使用されます。メジャー番号とマイナー番号の範囲、および関連する sd 名は、検出されると各デバイスに割り当てられます。つまり、デバイスの検出順序が変わると、メジャー番号とマイナー番号の範囲、および関連する sd 名の関連付けが変わる可能性があります。

このような順序の変更は、以下の状況で発生する可能性があります。

- システム起動プロセスの並列化により、システム起動ごとに異なる順序でストレージデバイスが検出された場合。

-

ディスクが起動しなかったり、SCSI コントローラーに応答しなかった場合。この場合は、通常のデバイスプローブにより検出されません。ディスクはシステムにアクセスできなくなり、後続のデバイスは関連する次の

sd名が含まれる、メジャー番号およびマイナー番号の範囲があります。たとえば、通常sdbと呼ばれるディスクが検出されないと、sdcと呼ばれるディスクがsdbとして代わりに表示されます。 -

SCSI コントローラー (ホストバスアダプターまたは HBA) が初期化に失敗し、その HBA に接続されているすべてのディスクが検出されなかった場合。後続のプローブされた HBA に接続しているディスクは、別のメジャー番号およびマイナー番号の範囲、および関連する別の

sd名が割り当てられます。 - システムに異なるタイプの HBA が存在する場合は、ドライバー初期化の順序が変更する可能性があります。これにより、HBA に接続されているディスクが異なる順序で検出される可能性があります。また、HBA がシステムの他の PCI スロットに移動した場合でも発生する可能性があります。

-

ストレージアレイや干渉するスイッチの電源が切れた場合など、ストレージデバイスがプローブされたときに、ファイバーチャネル、iSCSI、または FCoE アダプターを持つシステムに接続されたディスクがアクセスできなくなる可能性があります。システムが起動するまでの時間よりもストレージアレイがオンラインになるまでの時間の方が長い場合に、電源の障害後にシステムが再起動すると、この問題が発生する可能性があります。一部のファイバーチャネルドライバーは WWPN マッピングへの永続 SCSI ターゲット ID を指定するメカニズムをサポートしますが、メジャー番号およびマイナー番号の範囲や関連する

sd名は予約されず、一貫性のある SCSI ターゲット ID 番号のみが提供されます。

そのため、/etc/fstab ファイルなどにあるデバイスを参照するときにメジャー番号およびマイナー番号の範囲や関連する sd 名を使用することは望ましくありません。誤ったデバイスがマウントされ、データが破損する可能性があります。

しかし、場合によっては他のメカニズムが使用される場合でも sd 名の参照が必要になる場合もあります (デバイスによりエラーが報告される場合など)。これは、Linux カーネルはデバイスに関するカーネルメッセージで sd 名 (および SCSI ホスト、チャネル、ターゲット、LUN タプル) を使用するためです。

6.2. ファイルシステムおよびデバイスの識別子

ファイルシステムの識別子は、ファイルシステム自体に関連付けられます。一方、デバイスの識別子は、物理ブロックデバイスに紐付けられます。適切なストレージ管理を行うには、その違いを理解することが重要です。

ファイルシステムの識別子

ファイルシステムの識別子は、ブロックデバイス上に作成された特定のファイルシステムに関連付けられます。識別子はファイルシステムの一部としても格納されます。ファイルシステムを別のデバイスにコピーしても、ファイルシステム識別子は同じです。ただし、mkfs ユーティリティーでフォーマットするなどしてデバイスを書き換えると、デバイスはその属性を失います。

ファイルシステムの識別子に含まれるものは、次のとおりです。

- 一意の ID (UUID)

- ラベル

デバイスの識別子

デバイス識別子は、ブロックデバイス (ディスクやパーティションなど) に関連付けられます。mkfs ユーティリティーでフォーマットするなどしてデバイスを書き換えた場合、デバイスはファイルシステムに格納されていないため、属性を保持します。

デバイスの識別子に含まれるものは、次のとおりです。

- World Wide Identifier (WWID)

- パーティション UUID

- シリアル番号

推奨事項

- 論理ボリュームなどの一部のファイルシステムは、複数のデバイスにまたがっています。Red Hat は、デバイスの識別子ではなくファイルシステムの識別子を使用してこのファイルシステムにアクセスすることを推奨します。

6.3. /dev/disk/ にある udev メカニズムにより管理されるデバイス名

udev メカニズムは、Linux のすべてのタイプのデバイスに使用され、ストレージデバイスだけに限定されません。/dev/disk/ ディレクトリーにさまざまな種類の永続的な命名属性を提供します。ストレージデバイスの場合、Red Hat Enterprise Linux には /dev/disk/ ディレクトリーにシンボリックリンクを作成する udev ルールが含まれています。これにより、次の方法でストレージデバイスを参照できます。

- ストレージデバイスのコンテンツ

- 一意の ID

- シリアル番号

udev の命名属性は永続的なものですが、システムを再起動しても自動的には変更されないため、設定可能なものもあります。

6.3.1. ファイルシステムの識別子

/dev/disk/by-uuid/ の UUID 属性

このディレクトリーのエントリーは、デバイスに格納されているコンテンツ (つまりデータ) 内の 一意の ID (UUID) によりストレージデバイスを参照するシンボリック名を提供します。以下に例を示します。

/dev/disk/by-uuid/3e6be9de-8139-11d1-9106-a43f08d823a6

次の構文を使用することで、UUID を使用して /etc/fstab ファイルのデバイスを参照できます。

UUID=3e6be9de-8139-11d1-9106-a43f08d823a6ファイルシステムを作成する際に UUID 属性を設定できます。後で変更することもできます。

/dev/disk/by-label/ のラベル属性

このディレクトリーのエントリーは、デバイスに格納されているコンテンツ (つまりデータ) 内の ラベル により、ストレージデバイスを参照するシンボリック名を提供します。

以下に例を示します。

/dev/disk/by-label/Boot

次の構文を使用することで、ラベルを使用して /etc/fstab ファイルのデバイスを参照できます。

LABEL=Bootファイルシステムを作成するときにラベル属性を設定できます。また、後で変更することもできます。

6.3.2. デバイスの識別子

/dev/disk/by-id/ の WWID 属性

World Wide Identifier (WWID) は永続的で、SCSI 規格によりすべての SCSI デバイスが必要とする システムに依存しない識別子 です。各ストレージデバイスの WWID 識別子は一意となることが保証され、デバイスのアクセスに使用されるパスに依存しません。この識別子はデバイスのプロパティーですが、デバイスのコンテンツ (つまりデータ) には格納されません。

この識別子は、SCSI Inquiry を発行して Device Identification Vital Product Data (0x83 ページ) または Unit Serial Number (0x80 ページ) を取得することにより獲得できます。

Red Hat Enterprise Linux では、WWID ベースのデバイス名から、そのシステムの現在の /dev/sd 名への正しいマッピングを自動的に維持します。デバイスへのパスが変更したり、別のシステムからそのデバイスへのアクセスがあった場合にも、アプリケーションはディスク上のデータ参照に /dev/disk/by-id/ を使用できます。

NVMe デバイスを使用している場合、デバイスのシリアル番号の先頭に空白があると、一部のベンダーのディスク ID による名前変更が発生する可能性があります。

例6.1 WWID マッピング

| WWID シンボリックリンク | 非永続的なデバイス | 備考 |

|---|---|---|

|

|

|

ページ |

|

|

|

ページ |

|

|

| ディスクパーティション |

システムにより提供される永続的な名前のほかに、udev ルールを使用して独自の永続的な名前を実装し、ストレージの WWID にマップすることもできます。

/dev/disk/by-partuuid のパーティション UUID 属性

パーティション UUID (PARTUUID) 属性は、GPT パーティションテーブルにより定義されているパーティションを識別します。

例6.2 パーティション UUID のマッピング

| PARTUUID シンボリックリンク | 非永続的なデバイス |

|---|---|

|

|

|

|

|

|

|

|

|

/dev/disk/by-path/ のパス属性

この属性は、デバイスへのアクセスに使用される ハードウェアパス がストレージデバイスを参照するシンボル名を提供します。

ハードウェアパス (PCI ID、ターゲットポート、LUN 番号など) の一部が変更されると、パス属性に失敗します。このため、パス属性は信頼性に欠けます。ただし、パス属性は以下のいずれかのシナリオで役に立ちます。

- 後で置き換える予定のディスクを特定する必要があります。

- 特定の場所にあるディスクにストレージサービスをインストールする予定です。

6.4. DM Multipath を使用した World Wide Identifier

Device Mapper (DM) Multipath を設定して、World Wide Identifier (WWID) と非永続的なデバイス名をマッピングできます。

システムからデバイスへのパスが複数ある場合、DM Multipath はこれを検出するために WWID を使用します。その後、DM Multipath は /dev/mapper/wwid ディレクトリー (例: /dev/mapper/3600508b400105df70000e00000ac0000) に単一の "疑似デバイス" を表示します。

コマンド multipath -l は、非永続的な識別子へのマッピングを示します。

-

Host:Channel:Target:LUN -

/dev/sd名 -

major:minor数値

例6.3 マルチパス設定での WWID マッピング

multipath -l コマンドの出力例:

3600508b400105df70000e00000ac0000 dm-2 vendor,product [size=20G][features=1 queue_if_no_path][hwhandler=0][rw] \_ round-robin 0 [prio=0][active] \_ 5:0:1:1 sdc 8:32 [active][undef] \_ 6:0:1:1 sdg 8:96 [active][undef] \_ round-robin 0 [prio=0][enabled] \_ 5:0:0:1 sdb 8:16 [active][undef] \_ 6:0:0:1 sdf 8:80 [active][undef]

DM Multipath は、各 WWID ベースのデバイス名から、システムで対応する /dev/sd 名への適切なマッピングを自動的に維持します。これらの名前は、パスが変更しても持続し、他のシステムからデバイスにアクセスする際に一貫性を保持します。

DM Multipath の user_friendly_names 機能を使用すると、WWID は /dev/mapper/mpathN 形式の名前にマップされます。デフォルトでは、このマッピングは /etc/multipath/bindings ファイルに保持されています。これらの mpathN 名は、そのファイルが維持されている限り永続的です。

user_friendly_names を使用する場合は、クラスター内で一貫した名前を取得するために追加の手順が必要です。

6.5. udev デバイス命名規則の制約

udev 命名規則の制約の一部は次のとおりです。

-

udevイベントに対してudevルールが処理されるときに、udevメカニズムはストレージデバイスをクエリーする機能に依存する可能性があるため、クエリーの実行時にデバイスにアクセスできない可能性があります。これは、ファイバーチャネル、iSCSI、または FCoE ストレージデバイスといった、デバイスがサーバーシャーシにない場合に発生する可能性が高くなります。 -

カーネルは

udevイベントをいつでも送信する可能性があるため、デバイスにアクセスできない場合に/dev/disk/by-*/リンクが削除される可能性があります。 -

udevイベントが生成されそのイベントが処理されるまでに遅延が生じる場合があります (大量のデバイスが検出され、ユーザー空間のudevサービスによる各デバイスのルールを処理するのにある程度の時間がかかる場合など)。これにより、カーネルがデバイスを検出してから、/dev/disk/by-*/の名前が利用できるようになるまでに遅延が生じる可能性があります。 -

ルールに呼び出される

blkidなどの外部プログラムによってデバイスが短期間開き、他の目的でデバイスにアクセスできなくなる可能性があります。 -

/dev/disk/ の

udevメカニズムで管理されるデバイス名は、メジャーリリース間で変更される可能性があるため、リンクの更新が必要になる場合があります。

6.6. 永続的な命名属性のリスト表示

非永続ストレージデバイスの永続的な命名属性を確認できます。

手順

UUID 属性とラベル属性をリスト表示するには、

lsblkユーティリティーを使用します。$ lsblk --fs storage-device以下に例を示します。

例6.4 ファイルシステムの UUID とラベルの表示

$ lsblk --fs /dev/sda1 NAME FSTYPE LABEL UUID MOUNTPOINT sda1 xfs Boot afa5d5e3-9050-48c3-acc1-bb30095f3dc4 /boot

PARTUUID 属性をリスト表示するには、

--output +PARTUUIDオプションを指定してlsblkユーティリティーを使用します。$ lsblk --output +PARTUUID以下に例を示します。

例6.5 パーティションの PARTUUID 属性の表示

$ lsblk --output +PARTUUID /dev/sda1 NAME MAJ:MIN RM SIZE RO TYPE MOUNTPOINT PARTUUID sda1 8:1 0 512M 0 part /boot 4cd1448a-01

WWID 属性をリスト表示するには、

/dev/disk/by-id/ディレクトリーのシンボリックリンクのターゲットを調べます。以下に例を示します。例6.6 システムにある全ストレージデバイスの WWID の表示

$ file /dev/disk/by-id/* /dev/disk/by-id/ata-QEMU_HARDDISK_QM00001 symbolic link to ../../sda /dev/disk/by-id/ata-QEMU_HARDDISK_QM00001-part1 symbolic link to ../../sda1 /dev/disk/by-id/ata-QEMU_HARDDISK_QM00001-part2 symbolic link to ../../sda2 /dev/disk/by-id/dm-name-rhel_rhel8-root symbolic link to ../../dm-0 /dev/disk/by-id/dm-name-rhel_rhel8-swap symbolic link to ../../dm-1 /dev/disk/by-id/dm-uuid-LVM-QIWtEHtXGobe5bewlIUDivKOz5ofkgFhP0RMFsNyySVihqEl2cWWbR7MjXJolD6g symbolic link to ../../dm-1 /dev/disk/by-id/dm-uuid-LVM-QIWtEHtXGobe5bewlIUDivKOz5ofkgFhXqH2M45hD2H9nAf2qfWSrlRLhzfMyOKd symbolic link to ../../dm-0 /dev/disk/by-id/lvm-pv-uuid-atlr2Y-vuMo-ueoH-CpMG-4JuH-AhEF-wu4QQm symbolic link to ../../sda2

6.7. 永続的な命名属性の変更

ファイルシステムの UUID またはラベルの永続的な命名属性を変更できます。

udev 属性の変更はバックグラウンドで行われ、時間がかかる場合があります。udevadm settle コマンドは、変更が完全に登録されるまで待機します。そのため、その後のコマンドで確実に新しい属性を正しく使用できます。

以下のコマンドでは、次を行います。

-

new-uuid を、設定する UUID (例:

1cdfbc07-1c90-4984-b5ec-f61943f5ea50) に置き換えます。uuidgenコマンドを使用して UUID を生成できます。 -

new-label を、ラベル (例:

backup_data) に置き換えます。

前提条件

- XFS ファイルシステムをアンマウントしている (XFS ファイルシステムの属性を変更する場合)。

手順

XFS ファイルシステムの UUID またはラベル属性を変更するには、

xfs_adminユーティリティーを使用します。# xfs_admin -U new-uuid -L new-label storage-device # udevadm settle

ext4 ファイルシステム、ext3 ファイルシステム、ext2 ファイルシステムの UUID またはラベル属性を変更するには、

tune2fsユーティリティーを使用します。# tune2fs -U new-uuid -L new-label storage-device # udevadm settle

スワップボリュームの UUID またはラベル属性を変更するには、

swaplabelユーティリティーを使用します。# swaplabel --uuid new-uuid --label new-label swap-device # udevadm settle

第7章 parted でのパーティション操作

parted は、ディスクパーティションを操作するプログラムです。MS-DOS や GPT など、複数のパーティションテーブル形式をサポートしています。これは、新しいオペレーティングシステム用のスペースの作成、ディスクの使用方法の再編成、および新しいハードディスクへのデータのコピーに役立ちます。

7.1. parted でパーティションテーブルの表示

ブロックデバイスのパーティションテーブルを表示して、パーティションレイアウトと個々のパーティションの詳細を確認します。parted ユーティリティーを使用して、ブロックデバイスのパーティションテーブルを表示できます。

手順

partedユーティリティーを起動します。たとえば、次の出力は、デバイス/dev/sdaをリストします。# parted /dev/sdaパーティションテーブルを表示します。

(parted) print Model: ATA SAMSUNG MZNLN256 (scsi) Disk /dev/sda: 256GB Sector size (logical/physical): 512B/512B Partition Table: msdos Disk Flags: Number Start End Size Type File system Flags 1 1049kB 269MB 268MB primary xfs boot 2 269MB 34.6GB 34.4GB primary 3 34.6GB 45.4GB 10.7GB primary 4 45.4GB 256GB 211GB extended 5 45.4GB 256GB 211GB logicalオプション: 次に調べるデバイスに切り替えます。

(parted) select block-device

print コマンドの出力の詳細は、以下を参照してください。

Model: ATA SAMSUNG MZNLN256 (scsi)- ディスクタイプ、製造元、モデル番号、およびインターフェイス。

Disk /dev/sda: 256GB- ブロックデバイスへのファイルパスとストレージ容量。

Partition Table: msdos- ディスクラベルの種類。

Number-

パーティション番号。たとえば、マイナー番号 1 のパーティションは、

/dev/sda1に対応します。 StartおよびEnd- デバイスにおけるパーティションの開始場所と終了場所。

Type- 有効なタイプは、メタデータ、フリー、プライマリー、拡張、または論理です。

File system-

ファイルシステムの種類。ファイルシステムの種類が不明な場合は、デバイスの

File systemフィールドに値が表示されません。partedユーティリティーは、暗号化されたデバイスのファイルシステムを認識できません。 Flags-

パーティションのフラグ設定リスト。利用可能なフラグは、

boot、root、swap、hidden、raid、lvm、またはlbaです。

関連情報

-

システム上の

parted(8)man ページ

7.2. parted でディスクにパーティションテーブルを作成

parted ユーティリティーを使用して、より簡単にパーティションテーブルでブロックデバイスをフォーマットできます。

パーティションテーブルを使用してブロックデバイスをフォーマットすると、そのデバイスに保存されているすべてのデータが削除されます。

手順

インタラクティブな

partedシェルを起動します。# parted block-deviceデバイスにパーティションテーブルがあるかどうかを確認します。

(parted) printデバイスにパーティションが含まれている場合は、次の手順でパーティションを削除します。

新しいパーティションテーブルを作成します。

(parted) mklabel table-typetable-type を、使用するパーティションテーブルのタイプに置き換えます。

-

msdos(MBR の場合) -

gpt(GPT の場合)

-

例7.1 GUID パーティションテーブル (GPT) テーブルの作成

ディスクに GPT テーブルを作成するには、次のコマンドを使用します。

(parted) mklabel gptこのコマンドを入力すると、変更の適用が開始されます。

パーティションテーブルを表示して、作成されたことを確認します。

(parted) printpartedシェルを終了します。(parted) quit

関連情報

-

システム上の

parted(8)man ページ

7.3. parted でパーティションの作成

システム管理者は、parted ユーティリティーを使用してディスクに新しいパーティションを作成できます。

必要なパーティションは、swap、/boot/、および /(root) です。

前提条件

- ディスクのパーティションテーブル。

- 2TiB を超えるパーティションを作成する場合は、GUID Partition Table (GPT) でディスクをフォーマットしておく。

手順

partedユーティリティーを起動します。# parted block-device現在のパーティションテーブルを表示し、十分な空き領域があるかどうかを確認します。

(parted) print- 十分な空き容量がない場合は、パーティションのサイズを変更してください。

パーティションテーブルから、以下を確認します。

- 新しいパーティションの開始点と終了点

- MBR で、どのパーティションタイプにすべきか

新しいパーティションを作成します。

(parted) mkpart part-type name fs-type start end-

part-type を

primary、logical、またはextendedに置き換えます。これは MBR パーティションテーブルにのみ適用されます。 - name を任意のパーティション名に置き換えます。これは GPT パーティションテーブルに必要です。

-

fs-type を、

xfs、ext2、ext3、ext4、fat16、fat32、hfs、hfs+、linux-swap、ntfs、またはreiserfsに置き換えます。fs-type パラメーターは任意です。partedユーティリティーは、パーティションにファイルシステムを作成しないことに注意してください。 -

start と end を、パーティションの開始点と終了点を決定するサイズに置き換えます (ディスクの開始からカウントします)。

512MiB、20GiB、1.5TiBなどのサイズ接尾辞を使用できます。デフォルトサイズの単位はメガバイトです。

例7.2 小さなプライマリーパーティションの作成

MBR テーブルに 1024MiB から 2048MiB までのプライマリーパーティションを作成するには、次のコマンドを使用します。

(parted) mkpart primary 1024MiB 2048MiBコマンドを入力すると、変更の適用が開始されます。

-

part-type を

パーティションテーブルを表示して、作成されたパーティションのパーティションタイプ、ファイルシステムタイプ、サイズが、パーティションテーブルに正しく表示されていることを確認します。

(parted) printpartedシェルを終了します。(parted) quit新規デバイスノードを登録します。

# udevadm settleカーネルが新しいパーティションを認識していることを確認します。

# cat /proc/partitions

関連情報

-

システム上の

parted(8)man ページ - parted でディスクにパーティションテーブルを作成

- parted でパーティションのサイズ変更

7.4. parted でパーティションの削除

parted ユーティリティーを使用すると、ディスクパーティションを削除して、ディスク領域を解放できます。

パーティションを削除すると、そのパーティションに保存されているすべてのデータが削除されます。

手順

インタラクティブな

partedシェルを起動します。# parted block-device-

block-device を、パーティションを削除するデバイスへのパス (例:

/dev/sda) に置き換えます。

-

block-device を、パーティションを削除するデバイスへのパス (例:

現在のパーティションテーブルを表示して、削除するパーティションのマイナー番号を確認します。

(parted) printパーティションを削除します。

(parted) rm minor-number- minor-number を、削除するパーティションのマイナー番号に置き換えます。

このコマンドを実行すると、すぐに変更の適用が開始されます。

パーティションテーブルからパーティションが削除されたことを確認します。

(parted) printpartedシェルを終了します。(parted) quitパーティションが削除されたことをカーネルが登録していることを確認します。

# cat /proc/partitions-

パーティションが存在する場合は、

/etc/fstabファイルからパーティションを削除します。削除したパーティションを宣言している行を見つけ、ファイルから削除します。 システムが新しい

/etc/fstab設定を登録するように、マウントユニットを再生成します。# systemctl daemon-reloadスワップパーティション、または LVM の一部を削除した場合は、カーネルコマンドラインからパーティションへの参照をすべて削除します。

アクティブなカーネルオプションを一覧表示し、削除されたパーティションを参照するオプションがないか確認します。

# grubby --info=ALL削除されたパーティションを参照するカーネルオプションを削除します。

# grubby --update-kernel=ALL --remove-args="option"

アーリーブートシステムに変更を登録するには、

initramfsファイルシステムを再構築します。# dracut --force --verbose

関連情報

-

システム上の

parted(8)man ページ

7.5. parted でパーティションのサイズ変更

parted ユーティリティーを使用して、パーティションを拡張して未使用のディスク領域を利用したり、パーティションを縮小してその容量をさまざまな目的に使用したりできます。

前提条件

- パーティションを縮小する前にデータをバックアップする。

- 2TiB を超えるパーティションを作成する場合は、GUID Partition Table (GPT) でディスクをフォーマットしておく。

- パーティションを縮小する場合は、サイズを変更したパーティションより大きくならないように、最初にファイルシステムを縮小しておく。

XFS は縮小に対応していません。

手順

partedユーティリティーを起動します。# parted block-device現在のパーティションテーブルを表示します。

(parted) printパーティションテーブルから、以下を確認します。

- パーティションのマイナー番号。

- 既存のパーティションの位置とサイズ変更後の新しい終了点。

パーティションのサイズを変更します。

(parted) resizepart 1 2GiB- 1 を、サイズを変更するパーティションのマイナー番号に置き換えます。

-

2 を、サイズを変更するパーティションの新しい終了点を決定するサイズに置き換えます (ディスクの開始からカウントします)。

512MiB、20GiB、1.5TiBなどのサイズ接尾辞を使用できます。デフォルトサイズの単位はメガバイトです。

パーティションテーブルを表示して、サイズ変更したパーティションのサイズが、パーティションテーブルで正しく表示されていることを確認します。

(parted) printpartedシェルを終了します。(parted) quitカーネルが新しいパーティションを登録していることを確認します。

# cat /proc/partitions- オプション: パーティションを拡張した場合は、そこにあるファイルシステムも拡張します。

関連情報

-

システム上の

parted(8)man ページ

第8章 ディスクを再設定するストラテジー

ディスクのパーティションを再設定する方法は複数あります。これには以下が含まれます。

- パーティションが分割されていない空き領域が利用できる。

- 未使用のパーティションが利用可能である。

- アクティブに使用されているパーティションの空き領域が利用可能である。

以下の例は、わかりやすくするために単純化されており、実際に Red Hat Enterprise Linux をインストールするときの正確なパーティションレイアウトは反映していません。

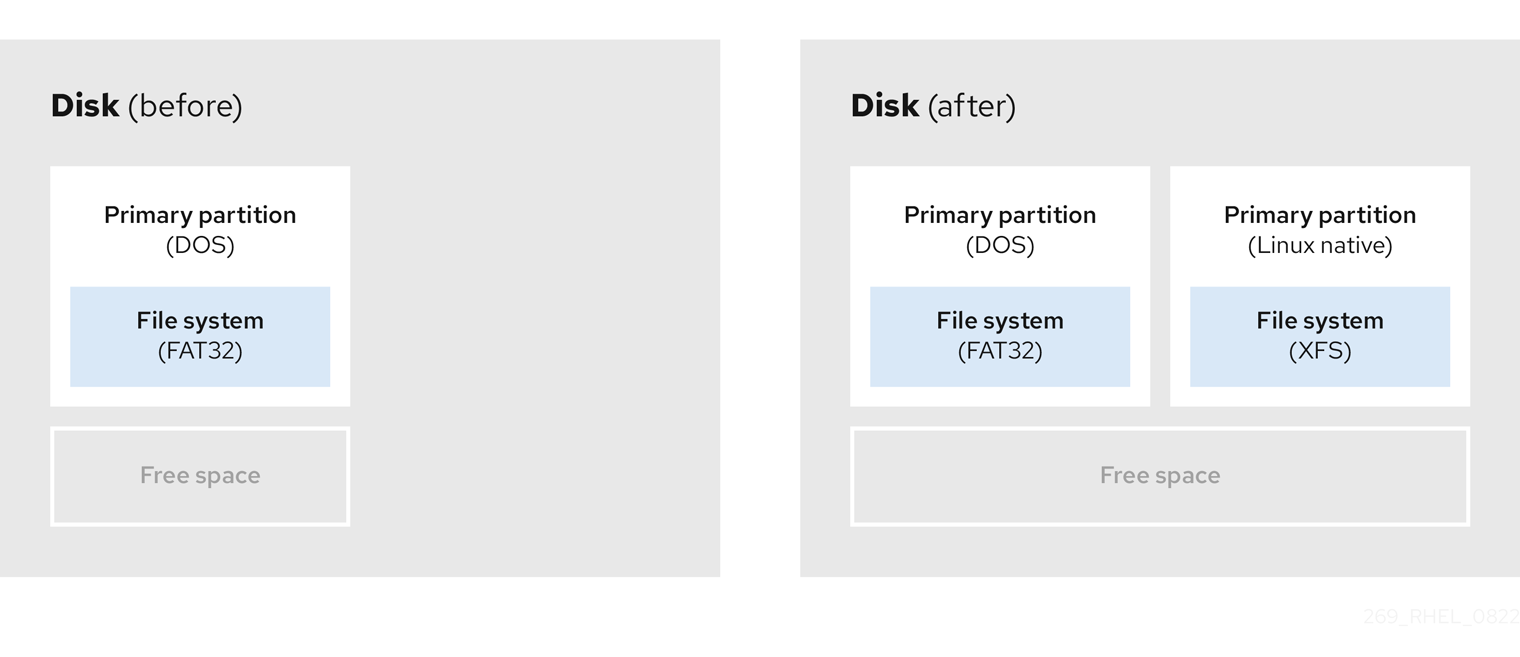

8.1. パーティションが分割されていない空き領域の使用

すでに定義されているパーティションはハードディスク全体にまたがらないため、定義されたパーティションには含まれない未割り当ての領域が残されます。次の図は、これがどのようになるかを示しています。

図8.1 パーティションが分割されていない空き領域があるディスク

最初の図は、1 つのプライマリーパーティションと未割り当て領域のある未定義のパーティションを持つディスクを表しています。2 番目の図は、スペースが割り当てられた 2 つの定義済みパーティションを持つディスクを表しています。

未使用のハードディスクもこのカテゴリーに分類されます。唯一の違いは、すべて の領域が定義されたパーティションの一部ではないことです。

新しいディスクでは、未使用の領域から必要なパーティションを作成できます。ほとんどのオペレーティングシステムは、ディスクドライブ上の利用可能な領域をすべて取得するように設定されています。

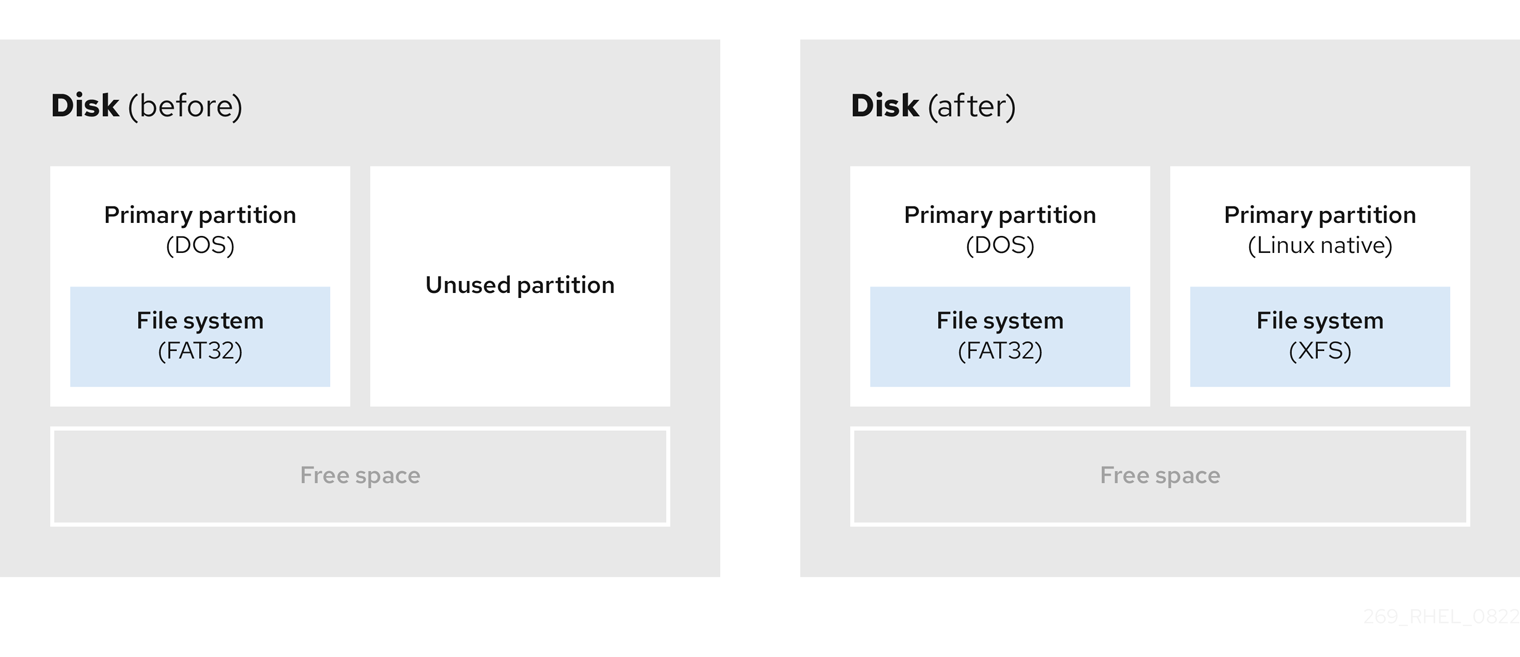

8.2. 未使用パーティションの領域の使用

次の例の最初の図は、未使用のパーティションを持つディスクを表しています。2 番目の図は、Linux の未使用パーティションの再割り当てを表しています。

図8.2 未使用のパーティションがあるディスク

未使用のパーティションに割り当てられた領域を使用するには、パーティションを削除してから、代わりに適切な Linux パーティションを作成します。または、インストールプロセス時に未使用のパーティションを削除し、新しいパーティションを手動で作成します。

8.3. アクティブなパーティションの空き領域の使用

すでに使用されているアクティブなパーティションには、必要な空き領域が含まれているため、このプロセスの管理は困難な場合があります。ほとんどの場合、ソフトウェアが事前にインストールされているコンピューターのハードディスクには、オペレーティングシステムとデータを保持する大きなパーティションが 1 つ含まれます。

アクティブなパーティションでオペレーティングシステム (OS) を使用する場合は、OS を再インストールする必要があります。ソフトウェアが事前にインストールされている一部のコンピューターには、元の OS を再インストールするためのインストールメディアが含まれていないことに注意してください。元のパーティションと OS インストールを破棄する前に、これが OS に当てはまるか確認してください。

使用可能な空き領域の使用を最適化するには、破壊的または非破壊的なパーティション再設定の方法を使用できます。

8.3.1. 破壊的な再設定

破壊的なパーティション再設定は、ハードドライブのパーティションを破棄し、代わりにいくつかの小さなパーティションを作成します。この方法は完全にコンテンツを削除するため、元のパーティションから必要なデータをバックアップします。

既存のオペレーティングシステム用に小規模なパーティションを作成すると、以下が可能になります。

- ソフトウェアをの再インストール。

- データの復元。

- Red Hat Enterprise Linux インストールの開始。

以下の図は、破壊的なパーティション再設定の方法を使用を簡潔に示しています。

図8.3 ディスク上での破壊的な再パーティション処理

このメソッドは、元のパーティションに保存されたデータをすべて削除します。

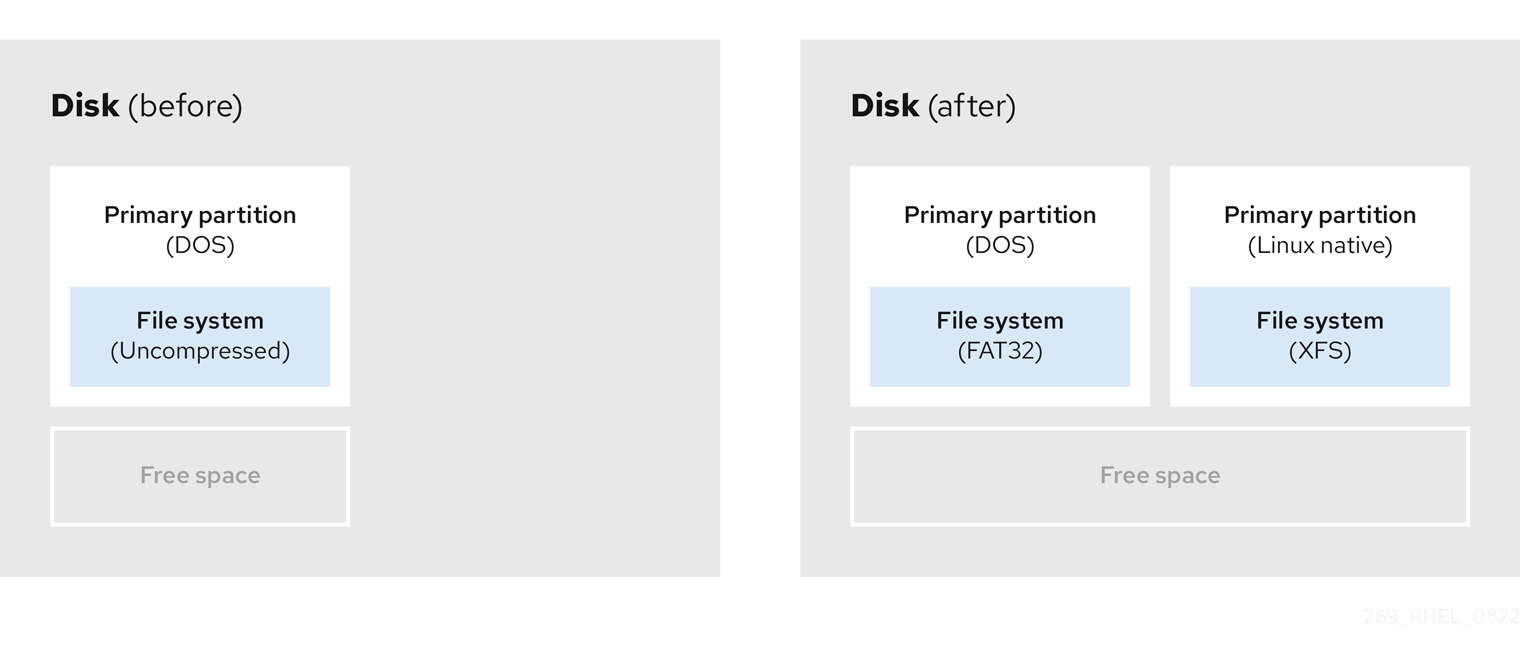

8.3.2. 非破壊的な再パーティション

非破壊的なパーティション再設定では、データの損失なしにパーティションのサイズを変更します。この方法は信頼性できますが、大きなドライブでは処理に時間がかかります。

以下は、破壊的なパーティション再設定の開始に役立つメソッドのリストです。

- 既存データの圧縮

一部のデータの保存場所は変更できません。これにより、必要なサイズへのパーティションのサイズ変更が妨げられ、最終的に破壊的なパーティション再設定プロセスが必要になる可能性があります。既存のパーティションでデータを圧縮すると、必要に応じてパーティションのサイズを変更できます。また、使用可能な空き容量を最大化することもできます。

以下の図は、このプロセスを簡略化したものです。

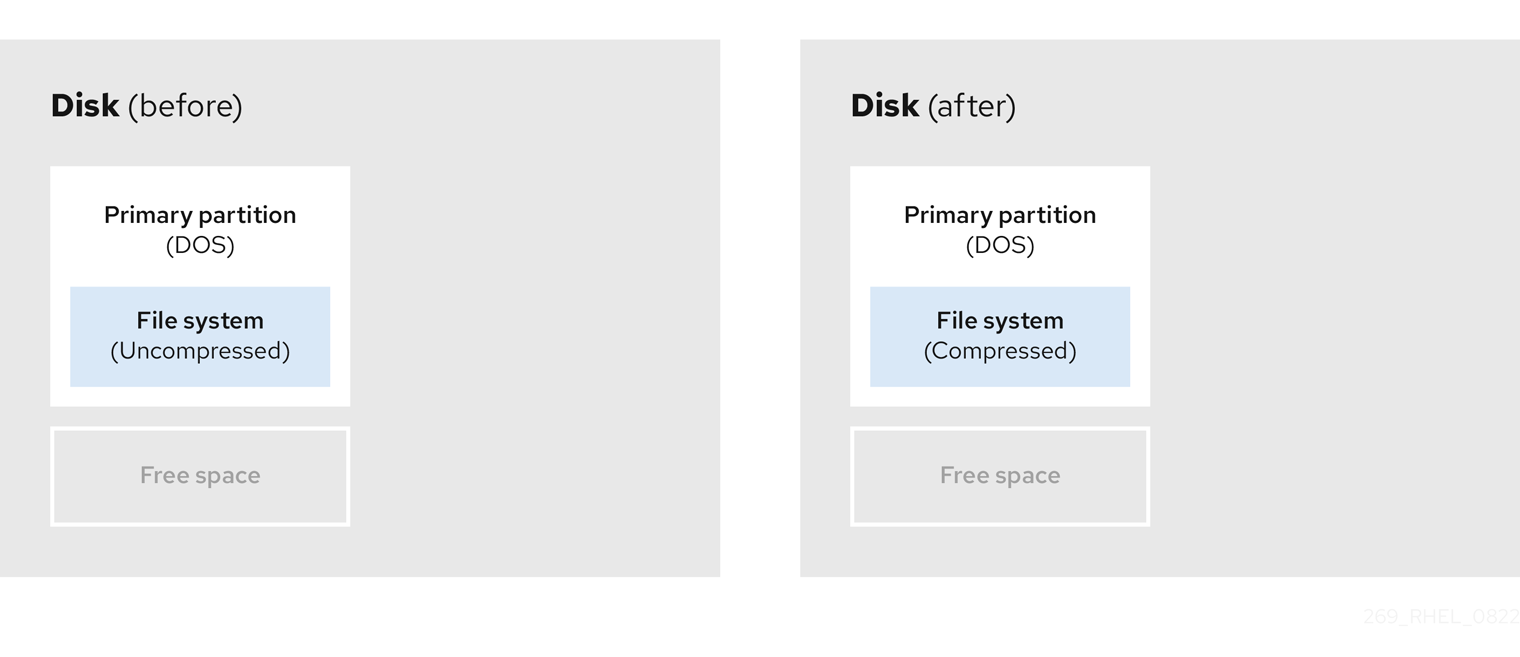

図8.4 ディスク上でのデータ圧縮

データ損失の可能性を回避するには、圧縮プロセスを続行する前にバックアップを作成します。

- 既存パーティションのサイズ変更

既存のパーティションのサイズを変更すると、より多くの領域を解放できます。結果は、サイズ変更ソフトウェアにより異なります。多くの場合、元のパーティションと同じタイプのフォーマットされていない新しいパーティションを作成できます。

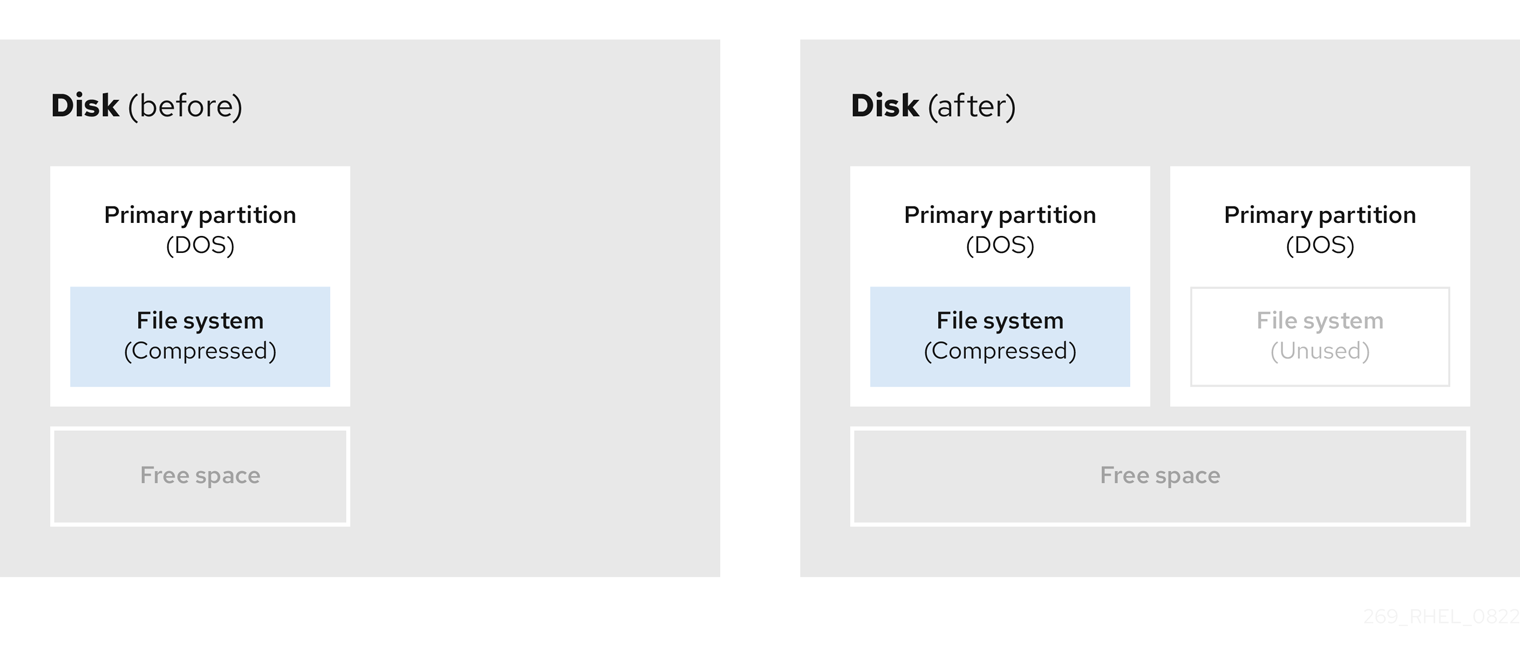

サイズ変更後の手順は、使用するソフトウェアにより異なります。以下の例では、新しい DOS (Disk Operating System) パーティションを削除し、代わりに Linux パーティションを作成することを推奨します。サイズ変更プロセスを開始する前に、何がディスクに最適か確認してください。

図8.5 ディスク上でのパーティションのサイズ変更

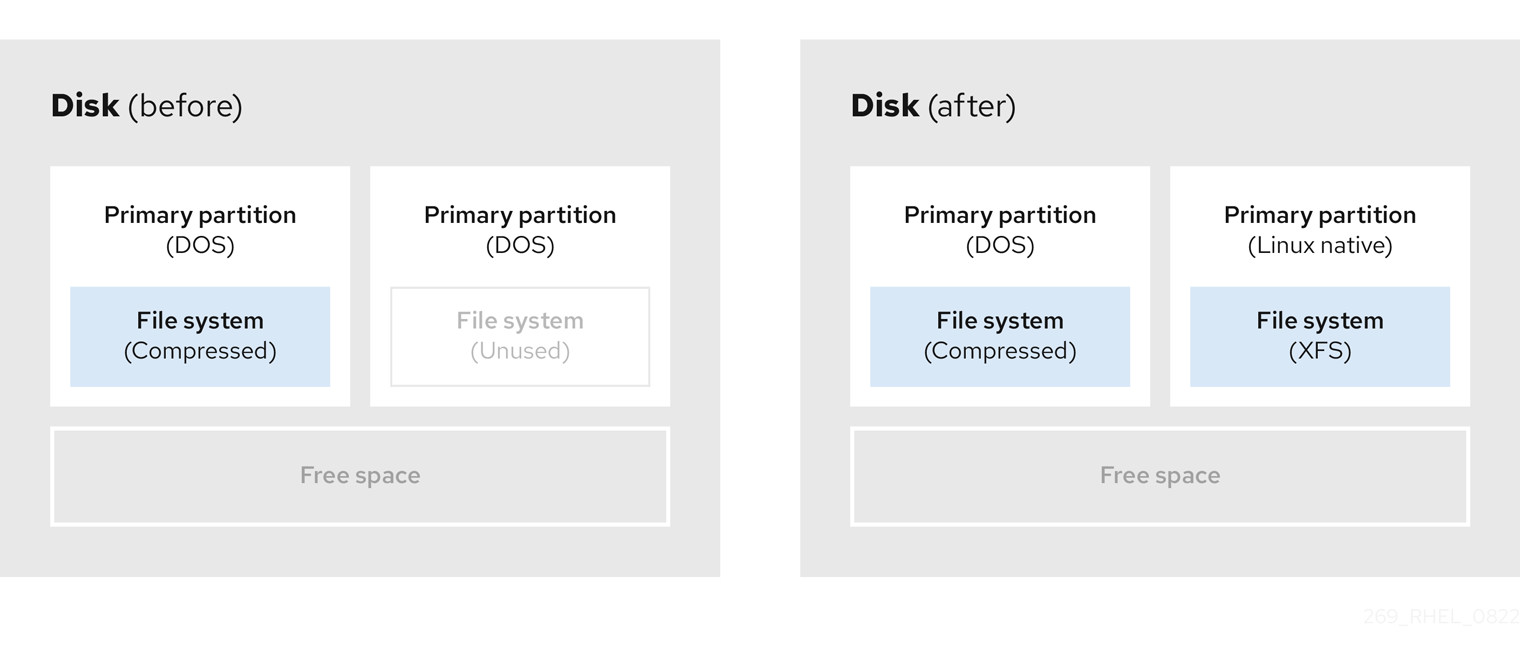

- オプション: 新規パーティションの作成

一部のサイズ変更ソフトウェアは、Linux ベースのシステムをサポートしています。この場合、サイズ変更後に新たに作成されたパーティションを削除する必要はありません。新しいパーティションの作成方法は、使用するソフトウェアによって異なります。

以下の図は、新しいパーティションを作成する前後のディスクの状態を示しています。

図8.6 最終パーティション設定のディスク

第9章 XFS の使用

これは、XFS ファイルシステムを作成および維持する方法の概要です。

9.1. XFS ファイルシステム

XFS は、拡張性が高く、高性能で堅牢な、成熟した 64 ビットのジャーナリングファイルシステムで、1 台のホストで非常に大きなファイルおよびファイルシステムに対応します。Red Hat Enterprise Linux 9 ではデフォルトのファイルシステムになります。XFS は、元々 1990 年代の前半に SGI により開発され、極めて大規模なサーバーおよびストレージアレイで実行されてきた長い歴史があります。

XFS の機能は次のとおりです。

- 信頼性

- メタデータジャーナリング - システムの再起動時、およびファイルシステムの再マウント時に再生できるファイルシステム操作の記録を保持することで、システムクラッシュ後のファイルシステムの整合性を確保します。

- 広範囲に及ぶランタイムメタデータの整合性チェック

- 拡張性が高く、高速な修復ユーティリティー

- クォータジャーナリングクラッシュ後に行なわれる、時間がかかるクォータの整合性チェックが不要になります。

- スケーラビリティーおよびパフォーマンス

- 対応するファイルシステムのサイズが最大 1024 TiB

- 多数の同時操作に対応する機能

- 空き領域管理のスケーラビリティーに関する B-Tree インデックス

- 高度なメタデータ先読みアルゴリズム

- ストリーミングビデオのワークロードの最適化

- 割り当てスキーム

- エクステント (領域) ベースの割り当て

- ストライプを認識できる割り当てポリシー

- 遅延割り当て

- 領域の事前割り当て

- 動的に割り当てられる inode

- その他の機能

- Reflink ベースのファイルのコピー

- 密接に統合されたバックアップおよび復元のユーティリティー

- オンラインのデフラグ

- オンラインのファイルシステム拡張

- 包括的な診断機能

-

拡張属性 (

xattr)。これにより、システムが、ファイルごとに、名前と値の組み合わせを追加で関連付けられるようになります。 - プロジェクトまたはディレクトリーのクォータ。ディレクトリーツリー全体にクォータ制限を適用できます。

- サブセカンド (一秒未満) のタイムスタンプ

パフォーマンスの特徴

XFS は、エンタープライズレベルのワークロードがある大規模なシステムで優れたパフォーマンスを発揮します。大規模なシステムとは、相対的に CPU 数が多く、さらには複数の HBA、および外部ディスクアレイへの接続を備えたシステムです。XFS は、マルチスレッドの並列 I/O ワークロードを備えた小規模のシステムでも適切に実行します。

XFS は、シングルスレッドで、メタデータ集約型のワークロードのパフォーマンスが比較的低くなります。たとえば、シングルスレッドで小さなファイルを多数作成し、削除するワークロードがこれに当てはまります。

9.2. ext4 および XFS で使用されるツールの比較

このセクションでは、ext4 ファイルシステムおよび XFS ファイルシステムで一般的なタスクを行うのに使用するツールを比較します。

| タスク | ext4 | XFS |

|---|---|---|

| ファイルシステムを作成する |

|

|

| ファイルシステム検査 |

|

|

| ファイルシステムのサイズを変更する |

|

|

| ファイルシステムのイメージを保存する |

|

|

| ファイルシステムのラベル付けまたはチューニングを行う |

|

|

| ファイルシステムのバックアップを作成する |

|

|

| クォータ管理 |

|

|

| ファイルマッピング |

|

|

ネットワークを使用してバックアップするための完全なクライアント/サーバーソリューションが必要な場合は、RHEL 9 で利用可能な bacula バックアップユーティリティーを使用できます。Bacula の詳細は、Bacula backup solution を参照してください。

第10章 XFS ファイルシステムの作成

システム管理者は、ブロックデバイスに XFS ファイルシステムを作成して、ファイルやディレクトリーを格納できます。

10.1. mkfs.xfs で XFS ファイルシステムの作成

この手順では、ブロックデバイスに XFS ファイルシステムを作成する方法を説明します。

手順

ファイルシステムを作成する場合は、以下の手順を実行します。

デバイスが通常のパーティション、LVM ボリューム、MD ボリューム、ディスク、または類似デバイスである場合は、次のコマンドを使用します。

# mkfs.xfs block-device-

block-device を、ブロックデバイスへのパスに置き換えます。たとえば、

/dev/sdb1、/dev/disk/by-uuid/05e99ec8-def1-4a5e-8a9d-5945339ceb2a、または/dev/my-volgroup/my-lvです。 - 通常、デフォルトのオプションは、一般的な使用に最適なものです。

-

既存のファイルシステムを含むブロックデバイスで

mkfs.xfsを使用する場合は、そのファイルシステムを上書きする-fオプションを追加してください。

-

block-device を、ブロックデバイスへのパスに置き換えます。たとえば、

ハードウェア RAID デバイスにファイルシステムを作成する場合は、システムがデバイスのストライプジオメトリーを正しく検出しているかどうかを確認します。

ストライプジオメトリー情報が正しい場合は、追加のオプションが必要ありません。ファイルシステムを作成します。

# mkfs.xfs block-device情報が正しくない場合は、

-dオプションのsuパラメーターおよびswパラメーターを使用して、ストライプジオメトリーを手動で指定します。suパラメーターは RAID チャンクサイズを指定し、swパラメーターは RAID デバイス内のデータディスクの数を指定します。以下に例を示します。

# mkfs.xfs -d su=64k,sw=4 /dev/sda3

次のコマンドを使用して、システムが新しいデバイスノードを登録するまで待機します。

# udevadm settle

関連情報

-

システム上の

mkfs.xfs(8)man ページ

第11章 XFS ファイルシステムのバックアップ

システム管理者は、xfsdump を使用して XFS ファイルシステムをファイルまたはテープにバックアップできます。これは、簡単なバックアップメカニズムを提供します。

11.1. XFS バックアップの機能

このセクションでは、xfsdump ユーティリティーを使用して XFS ファイルシステムをバックアップする場合の主な概念と機能を説明します。

xfsdump ユーティリティーを使用すると次のことができます。

通常のファイルイメージへのバックアップ

通常のファイルに書き込むことができるバックアップは 1 つだけです。

テープドライブへのバックアップ

xfsdumpユーティリティーを使用すると、同じテープに複数のバックアップを書き込むこともできます。バックアップは、複数のテープを分割して書き込むことができます。複数のファイルシステムのバックアップを 1 つのテープデバイスに作成するには、XFS バックアップがすでに含まれているテープにバックアップを書き込みます。これにより、古いバックアップに、新しいバックアップが追加されます。

xfsdumpは、デフォルトでは既存のバックアップを上書しません。増分バックアップの作成

xfsdumpユーティリティーはダンプレベルを使用して、その他のバックアップの相対的なベースバックアップを決定します。0 から 9 までの数字は、ダンプレベルの増加を表します。増分バックアップは、下位レベルの最後のダンプ以降に変更したファイルのみが対象となります。- フルバックアップを実行する場合は、ファイルシステムでレベル 0 のダンプを実行します。

- レベル 1 のダンプは、フルバックアップ後の最初の増分バックアップです。次の増分バックアップはレベル 2 になります。これは、前回のレベル 1 のダンプ以降に変更したファイルのみが対象となります。レベル 9 まで同様です。

- ファイルを絞り込むサイズ、サブツリー、または inode のフラグを使用して、バックアップからファイルを除外

関連情報

-

システム上の

xfsdump(8)man ページ

11.2. xfsdump で XFS ファイルシステムのバックアップ

この手順では、XFS ファイルシステムのコンテンツのバックアップを、ファイルまたはテープに作成する方法を説明します。

前提条件

- バックアップが可能な XFS ファイルシステム

- バックアップを保存できる別のファイルシステムまたはテープドライブ

手順

次のコマンドを使用して、XFS ファイルシステムのバックアップを作成します。

# xfsdump -l level [-L label] \ -f backup-destination path-to-xfs-filesystem-

level を、バックアップのダンプレベルに置き換えます。フルバックアップを実行する場合は

0を使用し、それに続く増分バックアップを実行する場合は1から9を使用します。 -

backup-destination を、バックアップを保存する場所のパスに置き換えます。保存場所は、通常のファイル、テープドライブ、またはリモートテープデバイスです。たとえば、ファイルの場合は

/backup-files/Data.xfsdump、テープドライブの場合は/dev/st0に置き換えます。 -

path-to-xfs-filesystem を、バックアップを作成する XFS ファイルシステムのマウントポイントに置き換えます。たとえば、

/mnt/data/に置き換えます。ファイルシステムをマウントする必要があります。 -

複数のファイルシステムのバックアップを作成して 1 つのテープデバイスに保存する場合は、復元時にそれらを簡単に識別できるように

-L labelオプションを使用して、各バックアップにセッションラベルを追加します。label を、バックアップの名前 (例:backup_data) に置き換えます。

-

level を、バックアップのダンプレベルに置き換えます。フルバックアップを実行する場合は

例11.1 複数の XFS ファイルシステムのバックアップ

/boot/ディレクトリーおよび/data/ディレクトリーにマウントされている XFS ファイルシステムのコンテンツのバックアップを作成し、作成したバックアップ内容をファイルとして/backup-files/ディレクトリーに保存するには、次のコマンドを実行します。# xfsdump -l 0 -f /backup-files/boot.xfsdump /boot # xfsdump -l 0 -f /backup-files/data.xfsdump /data

1 つのテープデバイスにある複数のファイルシステムのバックアップを作成する場合は、

-L labelオプションを使用して、各バックアップにセッションラベルを追加します。# xfsdump -l 0 -L "backup_boot" -f /dev/st0 /boot # xfsdump -l 0 -L "backup_data" -f /dev/st0 /data

関連情報

-

システム上の

xfsdump(8)man ページ

第12章 バックアップからの XFS ファイルシステムの復元

システム管理者は、xfsrestore ユーティリティーを使用して、xfsdump ユーティリティーで作成され、ファイルまたはテープに保存されている XFS バックアップを復元できます。

12.1. バックアップから XFS を復元する機能

xfsrestore ユーティリティーは、xfsdump により作成されたバックアップからファイルシステムを復元します。xfsrestore ユーティリティーには 2 つのモードがあります。

- simple モードでは、ユーザーはレベル 0 のダンプからファイルシステム全体を復元できます。これがデフォルトのモードです。

- cumulative モードでは、増分バックアップ (つまりレベル 1 からレベル 9) からファイルシステムを復元できます。

各バックアップは、session ID または session label で一意に識別されます。複数のバックアップを含むテープからバックアップを復元するには、対応するセッション ID またはラベルが必要です。

バックアップから特定のファイルを抽出、追加、または削除するには、xfsrestore インタラクティブモードを起動します。インタラクティブモードでは、バックアップファイルを操作する一連のコマンドが提供されます。

関連情報

-

システム上の

xfsrestore(8)man ページ

12.2. xfsrestore を使用してバックアップから XFS ファイルシステムを復元

この手順では、XFS ファイルシステムの内容を、ファイルまたはテープのバックアップから復元する方法を説明します。

前提条件

- XFS ファイルシステムのバックアップの作成 の説明に従って、XFS ファイルシステムのファイルまたはテープのバックアップ

- バックアップを復元できるストレージデバイス。

手順

バックアップを復元するコマンドは、フルバックアップから復元するか、増分バックアップから復元するか、1 つのテープデバイスから複数のバックアップを復元するかによって異なります。

# xfsrestore [-r] [-S session-id] [-L session-label] [-i] -f backup-location restoration-path-

backup-location を、バックアップの場所に置き換えます。これは、通常のファイル、テープドライブ、またはリモートテープデバイスになります。たとえば、ファイルの場合は

/backup-files/Data.xfsdump、テープドライブの場合は/dev/st0に置き換えます。 -

restoration-path を、ファイルシステムを復元するディレクトリーへのパスに置き換えます。たとえば、

/mnt/data/に置き換えます。 -

ファイルシステムを増分 (レベル 1 からレベル 9) バックアップから復元するには、

-rオプションを追加します。 複数のバックアップを含むテープデバイスからバックアップを復元するには、

-Sオプションまたは-Lオプションを使用してバックアップを指定します。-Sオプションではセッション ID でバックアップを選択でき、-Lオプションではセッションラベルで選択できます。セッション ID とセッションラベルを取得するには、xfsrestore -Iコマンドを使用します。session-id を、バックアップのセッション ID に置き換えます。たとえば、

b74a3586-e52e-4a4a-8775-c3334fa8ea2cに置き換えます。session-label を、バックアップのセッションラベルに置き換えます。たとえば、my_backup_session_labelに置き換えます。xfsrestoreをインタラクティブに使用するには、-iオプションを使用します。インタラクティブダイアログは、指定されたデバイスの、

xfsrestoreによる読み取りが終了してから始まります。インタラクティブなxfsrestoreシェルの使用可能なコマンドには、cd、ls、add、delete、extractがあります。コマンドの全リストを見るには、helpコマンドを使用します。

-

backup-location を、バックアップの場所に置き換えます。これは、通常のファイル、テープドライブ、またはリモートテープデバイスになります。たとえば、ファイルの場合は

例12.1 複数の XFS ファイルシステムの復元

XFS バックアップファイルを復元し、その内容を

/mnt/配下のディレクトリーに保存するには、次のコマンドを実行します。# xfsrestore -f /backup-files/boot.xfsdump /mnt/boot/ # xfsrestore -f /backup-files/data.xfsdump /mnt/data/

複数のバックアップを含むテープデバイスから復元するには、各バックアップをセッションラベルまたはセッション ID で指定します。

# xfsrestore -L "backup_boot" -f /dev/st0 /mnt/boot/ # xfsrestore -S "45e9af35-efd2-4244-87bc-4762e476cbab" \ -f /dev/st0 /mnt/data/

関連情報

-

システム上の

xfsrestore(8)man ページ

12.3. テープから XFS バックアップを復元するときの情報メッセージ

複数のファイルシステムのバックアップを使用してテープからバックアップを復元するとき、xfsrestore ユーティリティーがメッセージを出力することがあります。メッセージは、xfsrestore がテープ上の各バックアップを順番に調べたときに、要求されたバックアップと一致するものが見つかったかどうかを通知します。以下に例を示します。

xfsrestore: preparing drive xfsrestore: examining media file 0 xfsrestore: inventory session uuid (8590224e-3c93-469c-a311-fc8f23029b2a) does not match the media header's session uuid (7eda9f86-f1e9-4dfd-b1d4-c50467912408) xfsrestore: examining media file 1 xfsrestore: inventory session uuid (8590224e-3c93-469c-a311-fc8f23029b2a) does not match the media header's session uuid (7eda9f86-f1e9-4dfd-b1d4-c50467912408) [...]

情報メッセージは、一致するバックアップが見つかるまで継続して表示されます。

第13章 XFS ファイルシステムのサイズの拡大

システム管理者は、XFS ファイルシステムのサイズを増やして、より大きなストレージ容量を最大限に活用できます。

現在、XFS ファイルシステムのサイズを縮小することはできません。

13.1. xfs_growfs で XFS ファイルシステムのサイズの拡大

この手順では、xfs_growfs ユーティリティーを使用して XFS ファイルシステムを拡張する方法を説明します。

前提条件

- 基礎となるブロックデバイスのサイズが、後でファイルシステムのサイズを変更するのに十分な大きさである。該当するブロックデバイスのサイズを変更する場合は、ブロックデバイスに適した方法を選択してください。

- XFS ファイルシステムをマウントしている。

手順

XFS ファイルシステムのマウント時に、

xfs_growfsユーティリティーを使用してサイズを大きくします。# xfs_growfs file-system -D new-size- file-system を、XFS ファイルシステムのマウントポイントに置き換えます。

-Dオプションを指定して、new-size を、ファイルシステムブロックの数で指定されているファイルシステムの新しいサイズに置き換えます。特定の XFS ファイルシステムのブロックサイズ (KB 単位) を調べるには、

xfs_infoユーティリティーを使用します。# xfs_info block-device ... data = bsize=4096 ...-

xfs_growfsは、-Dオプションを指定しないと、基となるデバイスがサポートする最大サイズまでファイルシステムを拡張します。

関連情報

-

システム上の

xfs_growfs(8)man ページ

第14章 XFS エラー動作の設定

異なる I/O エラーが発生すると、XFS ファイルシステムの動作を設定できます。

14.1. XFS で設定可能なエラー処理

XFS ファイルシステムは、I/O 操作中にエラーが発生すると、以下のいずれかの方法で応答します。

XFS は、操作が成功するまで、または XFS が設定制限に到達するまで I/O 操作を繰り返し再試行します。

この制限は、再試行の最大数または再試行の最大時間を基にしています。

- XFS は、エラーを永続的に考慮し、ファイルシステムで操作を停止します。

XFS が以下のエラー条件に反応する方法を設定できます。

EIO- 読み取りまたは書き込み時のエラー

ENOSPC- デバイスに空き容量がない

ENODEV- デバイスが見つからない

最大再試行回数と、XFS がエラーを永続的と見なすまでの最大時間を秒単位で設定できます。XFS は、いずれかの制限に達すると操作の再試行を停止します。

また、ファイルシステムのマウントを解除するときに、他の設定に関係なく XFS が再試行を即座にキャンセルするように XFS を設定することもできます。この設定により、永続的なエラーを出しても、マウント解除操作は成功します。

デフォルトの動作

各 XFS エラー条件のデフォルトの動作は、エラーコンテキストによって異なります。ENODEV などの XFS エラーは、リトライ回数に関係なく致命的で回復不能とみなされます。デフォルトの再試行制限は 0 です。

14.2. 特定の、未定義の XFS エラー条件の設定ファイル

以下のディレクトリーは、さまざまなエラー状態に対して XFS エラー動作を制御する設定ファイルを保存します。

/sys/fs/xfs/device/error/metadata/EIO/-

EIOエラー条件の場合 /sys/fs/xfs/device/error/metadata/ENODEV/-

ENODEVエラー条件の場合 /sys/fs/xfs/device/error/metadata/ENOSPC/-

ENOSPCエラー条件の場合 /sys/fs/xfs/device/error/default/- その他のすべての未定義エラー条件の共通設定

各ディレクトリーには、再試行制限を設定するために以下の設定ファイルが含まれています。

max_retries- XFS が操作を再試行する最大回数を制御します。

retry_timeout_seconds- XFS が操作の再試行を停止するまでの時間制限を秒単位で指定します。

14.3. 特定の条件に対する XFS 動作の設定

この手順では、XFS が特定のエラー条件にどのように反応するかを設定します。

手順

再試行の最大数、再試行時間制限、またはその両方を設定します。

再試行の最大数を設定するには、必要な数を

max_retriesファイルに書き込みます。# echo value > /sys/fs/xfs/device/error/metadata/condition/max_retries時間制限を設定するには、希望する秒数を

retry_timeout_secondsファイルに書き込みます。# echo value > /sys/fs/xfs/device/error/metadata/condition/retry_timeout_second

value は、-1 から C 符号付き整数型の可能な最大値です。これは、64 ビットの Linux では 2147483647 です。

いずれの制限も、

-1の値は継続的な再試行に使用され、0は即座に停止するために使用されます。device は、

/dev/ディレクトリーにあるデバイス名です。たとえば、sdaです。

14.4. 未定義の条件に対する XFS 動作の設定

この手順では、XFS が、共通の設定を共有するすべての未定義のエラー条件に反応する方法を設定します。

手順

再試行の最大数、再試行時間制限、またはその両方を設定します。

再試行の最大数を設定するには、必要な数を

max_retriesファイルに書き込みます。# echo value > /sys/fs/xfs/device/error/metadata/default/max_retries時間制限を設定するには、希望する秒数を

retry_timeout_secondsファイルに書き込みます。# echo value > /sys/fs/xfs/device/error/metadata/default/retry_timeout_seconds

value は、-1 から C 符号付き整数型の可能な最大値です。これは、64 ビットの Linux では 2147483647 です。

いずれの制限も、

-1の値は継続的な再試行に使用され、0は即座に停止するために使用されます。device は、

/dev/ディレクトリーにあるデバイス名です。たとえば、sdaです。

14.5. XFS アンマウント動作の設定

この手順では、ファイルシステムのアンマウント時に XFS がエラー状態に対応するように設定します。

ファイルシステムに fail_at_unmount オプションを設定すると、マウント解除時にその他すべてのエラー設定が上書きされ、I/O 操作を再試行せずにすぐにファイルシステムをマウント解除します。これにより、永続的なエラーが発生した場合でも、マウント解除操作を成功できます。

マウント解除プロセスの開始後に fail_at_unmount の値を変更することはできません。アンマウントプロセスにより、設定ファイルが各ファイルシステムの sysfs インターフェイスから削除されます。ファイルシステムのマウント解除を開始する前に、マウント解除動作を設定する必要があります。

手順

fail_at_unmountオプションを有効または無効にします。ファイルシステムのマウント解除時にすべての操作を再試行する場合は、オプションを有効にします。

# echo 1 > /sys/fs/xfs/device/error/fail_at_unmountファイルシステムのマウント解除時に、再試行制限の

max_retriesおよびretry_timeout_secondsを回避するには、オプションを無効にします。# echo 0 > /sys/fs/xfs/device/error/fail_at_unmount

device は、

/dev/ディレクトリーにあるデバイス名です。たとえば、sdaです。

第15章 ファイルシステムの検査と修復

RHEL は、ファイルシステムの検査および修復が可能なファイルシステム管理ユーティリティーを提供します。このツールは、通常 fsck ツールと呼ばれることが多く、fsck は、file system check を短くした名前になります。ほとんどの場合、このようなユーティリティーは、必要に応じてシステムの起動時に自動的に実行しますが、必要な場合は手動で呼び出すこともできます。

ファイルシステムチェッカーは、ファイルシステム全体のメタデータの整合性のみを保証します。チェッカーは、ファイルシステムに含まれる実際のデータを認識しないため、データのリカバリーツールではありません。

15.1. ファイルシステムの検査が必要なシナリオ

以下のいずれかが発生した場合は、関連する fsck ツールを使用してシステムを検査できます。

- システムが起動しない

- 特定ディスクのファイルが破損する

- 不整合によりファイルシステムがシャットダウンするか、読み取り専用に変更する

- ファイルシステムのファイルにアクセスできない

ファイルシステムの不整合は、ハードウェアエラー、ストレージ管理エラー、ソフトウェアバグなどのさまざまな理由で発生する可能性があります。

ファイルシステムの検査ツールは、ハードウェアの問題を修復できません。修復を正常に動作させるには、ファイルシステムが完全に読み取り可能かつ書き込み可能である必要があります。ハードウェアエラーが原因でファイルシステムが破損した場合は、まず dd(8) ユーティリティーなどを使用して、ファイルシステムを適切なディスクに移動する必要があります。

ジャーナリングファイルシステムの場合、システムの起動時に通常必要なのは、必要に応じてジャーナルを再生することだけで、これは通常非常に短い操作になります。

ただし、ジャーナリングファイルシステムであっても、ファイルシステムの不整合や破損が発生した場合は、ファイルシステムチェッカーを使用してファイルシステムを修復する必要があります。

/etc/fstab の 6 番目のフィールドを 0 に設定すると、システムの起動時にファイルシステムの検査を無効にできます。ただし、Red Hat は、システムの起動時に fsck に問題がある場合 (非常に大きなファイルシステムやリモートファイルシステムなど) を除いて、無効にすることを推奨しません。

関連情報

-

システム上の

fstab(5)、fsck(8)、およびdd(8)man ページ

15.2. fsck の実行による潜在的な悪影響

通常、ファイルシステムの検査および修復のツールを実行すると、検出された不整合の少なくとも一部が自動的に修復されることが期待できます。場合によっては、以下の問題が発生する場合があります。

- inode やディレクトリーが大幅に損傷し、修復できない場合は、破棄される場合があります。

- ファイルシステムが大きく変更する場合があります。

予期しない変更や、望ましくない変更が永続的に行われないようにするには、この手順にまとめられている予防手順を行ってください。

15.3. XFS のエラー処理メカニズム

このセクションでは、XFS がファイルシステム内のさまざまな種類のエラーを処理する方法を説明します。

不完全なアンマウント

ジャーナリングは、ファイルシステムで発生したメタデータの変更のトランザクション記録を保持します。

システムクラッシュ、電源障害、またはその他の不完全なアンマウントが発生した場合、XFS はジャーナル (ログとも呼ばれる) を使用してファイルシステムを復旧します。カーネルは XFS ファイルシステムをマウントするときにジャーナルの復旧を実行します。

破損

この文脈での 破損 は、次のような原因によるファイルシステムのエラーを意味します。

- ハードウェア障害

- ストレージファームウェア、デバイスドライバー、ソフトウェアスタック、またはファイルシステム自体のバグ

- ファイルシステムの一部が、ファイルシステム外の何かにより上書きされる問題

XFS は、ファイルシステムまたはファイルシステムメタデータの破損を検出すると、ファイルシステムをシャットダウンして、システムログにインシデントを報告することがあります。/var ディレクトリーが置かれているファイルシステムで破損が発生すると、このログは再起動後に利用できなくなります。

例15.1 XFS の破損を報告するシステムログエントリー

# dmesg --notime | tail -15

XFS (loop0): Mounting V5 Filesystem

XFS (loop0): Metadata CRC error detected at xfs_agi_read_verify+0xcb/0xf0 [xfs], xfs_agi block 0x2

XFS (loop0): Unmount and run xfs_repair

XFS (loop0): First 128 bytes of corrupted metadata buffer:

00000000027b3b56: 00 00 00 00 00 00 00 00 00 00 00 00 00 00 00 00 ................

000000005f9abc7a: 00 00 00 00 00 00 00 00 00 00 00 00 00 00 00 00 ................

000000005b0aef35: 00 00 00 00 00 00 00 00 00 00 00 00 00 00 00 00 ................

00000000da9d2ded: 00 00 00 00 00 00 00 00 00 00 00 00 00 00 00 00 ................

000000001e265b07: 00 00 00 00 00 00 00 00 00 00 00 00 00 00 00 00 ................

000000006a40df69: 00 00 00 00 00 00 00 00 00 00 00 00 00 00 00 00 ................

000000000b272907: 00 00 00 00 00 00 00 00 00 00 00 00 00 00 00 00 ................

00000000e484aac5: 00 00 00 00 00 00 00 00 00 00 00 00 00 00 00 00 ................

XFS (loop0): metadata I/O error in "xfs_trans_read_buf_map" at daddr 0x2 len 1 error 74

XFS (loop0): xfs_imap_lookup: xfs_ialloc_read_agi() returned error -117, agno 0

XFS (loop0): Failed to read root inode 0x80, error 11ユーザー空間ユーティリティーは通常、破損した XFS ファイルシステムにアクセスしようとすると Input/output error メッセージを報告します。破損したログを使用して XFS ファイルシステムをマウントすると、マウントに失敗し、次のエラーメッセージが表示されます。

mount: /mount-point: mount(2) system call failed: Structure needs cleaning.

破損を修復するには、手動で xfs_repair ユーティリティーを使用する必要があります。

関連情報

-

システム上の

xfs_repair(8)man ページ

15.4. xfs_repair による XFS ファイルシステムの検査

xfs_repair ユーティリティーを使用して、XFS ファイルシステムの読み取り専用チェックを実行します。xfs_repair は、その他のファイルシステム修復ユーティリティーとは異なり、XFS ファイルシステムが正しくアンマウントされていなくても起動時には動作しません。正しくアンマウントされていない場合も、XFS はマウント時にログを再生するだけで、一貫したファイルシステムを確保します。xfs_repair は、ダーティーログがある XFS ファイルシステムを修復する場合、先にファイルシステムを再マウントする必要があります。

xfsprogs パッケージには fsck.xfs バイナリーがありますが、これは、システムの起動時に fsck.file システムバイナリーを検索する initscripts を満たすためにのみ存在します。fsck.xfs は、すぐに終了コード 0 で終了します。

手順

ファイルシステムをマウントおよびアンマウントしてログを再生します。

# mount file-system # umount file-system

注記マウントが structure needs cleaning (構造のクリーニングが必要) エラーで失敗した場合は、ログが破損しているため再生できません。ドライランは、結果として、より多くのディスク上の破損を検出して報告する必要があります。

xfs_repairユーティリティーを使用してドライランを実行し、ファイルシステムを検査します。エラーが表示され、ファイルシステムを変更せずに実行できるアクションが示されます。# xfs_repair -n block-deviceファイルシステムをマウントします。

# mount file-system

関連情報

-

システム上の

xfs_repair(8)およびxfs_metadump(8)man ページ

15.5. xfs_repair で XFS ファイルシステムの修復

この手順では、xfs_repair ユーティリティーを使用して破損した XFS ファイルシステムを修復します。

手順

xfs_metadumpユーティリティーを使用して、診断またはテストの目的で、修復する前にメタデータイメージを作成します。修復前のファイルシステムメタデータイメージは、破損がソフトウェアのバグによるものであるかどうかのサポート調査に役立ちます。修復前のイメージに含まれる破損のパターンは、根本的な分析に役に立つ場合があります。xfs_metadumpデバッグツールを使用して、XFS ファイルシステムからファイルにメタデータをコピーします。サポートに大きなメタダンプファイルを送信する必要がある場合は、標準の圧縮ユーティリティーを使用して生成されたメタダンプファイルを圧縮してファイルサイズを縮小できます。# xfs_metadump block-device metadump-file

ファイルシステムを再マウントしてログを再生します。

# mount file-system # umount file-system

アンマウントしたファイルシステムを修復するには、

xfs_repairユーティリティーを使用します。マウントが成功した場合、追加のオプションは必要ありません。

# xfs_repair block-deviceマウントが Structure needs cleaning エラーで失敗した場合は、ログが破損しているため再生できません。ログを消去するには、

-Lオプション (force log zeroing) を使用します。警告このコマンドを実行すると、クラッシュ時に進行中だったすべてのメタデータの更新が失われます。これにより、ファイルシステムに重大な損傷やデータ損失が生じる可能性があります。これは、ログを再生できない場合に最後の手段としてのみ使用してください。

# xfs_repair -L block-device

ファイルシステムをマウントします。

# mount file-system

関連情報

-

システム上の

xfs_repair(8)man ページ

15.6. ext2、ext3、および ext4 でエラー処理メカニズム

ext2、ext3、および ext4 のファイルシステムは、e2fsck ユーティリティーを使用して、ファイルシステムの検査と修復を実行します。ファイル名の fsck.ext2、fsck.ext3、および fsck.ext4 は、e2fsck ユーティリティーへのハードリンクです。これらのバイナリーは、システムの起動時に自動的に実行し、その動作は確認されるファイルシステムと、そのファイルシステムの状態によって異なります。

完全なファイルシステムの検査および修復は、メタデータジャーナリングファイルシステムではない ext2 や、ジャーナルのない ext4 ファイルシステムに対して呼び出されます。

メタデータジャーナリング機能のある ext3 ファイルシステムおよび ext4 ファイルシステムの場合、ジャーナルはユーザー空間で再生され、ユーティリティーは終了します。これは、ジャーナルの再生によりクラッシュ後のファイルシステムの整合性が確保されるためのデフォルト動作になります。

このファイルシステムで、マウント中にメタデータの不整合が生じると、その事実がファイルシステムのスーパーブロックに記録されます。e2fsck が、このようなエラーでファイルシステムがマークされていることを検出すると、e2fsck はジャーナル (がある場合) の再生後にフルチェックを実行します。

関連情報

-

システム上の

fsck(8)およびe2fsck(8)man ページ

15.7. e2fsck で ext2、ext3、または ext4 ファイルシステムの検査

この手順では、e2fsck ユーティリティーを使用して、ext2 ファイルシステム、ext3 ファイルシステム、または ext4 ファイルシステムを検査します。

手順

ファイルシステムを再マウントしてログを再生します。

# mount file-system # umount file-system

ドライランを実行して、ファイルシステムを検査します。

# e2fsck -n block-device注記エラーが表示され、ファイルシステムを変更せずに実行できるアクションが示されます。整合性チェック後のフェーズでは、修復モードで実行していた場合に前のフェーズで修正されていた不整合が検出される可能性があるため、追加のエラーが出力される場合があります。

関連情報

-

システム上の

e2image(8)およびe2fsck(8)man ページ

15.8. e2fsck で ext2、ext3、または ext4 ファイルシステムの修復

この手順では、e2fsck ユーティリティーを使用して、破損した ext2、ext3、または ext 4 のファイルシステムを修復します。

手順

サポート調査のためにファイルシステムイメージを保存します。修復前のファイルシステムメタデータイメージは、破損がソフトウェアのバグによるものであるかどうかのサポート調査に役立ちます。修復前のイメージに含まれる破損のパターンは、根本的な分析に役に立つ場合があります。

注記ファイルシステムが大幅に損傷している場合は、メタデータイメージの作成に関連して問題が発生する可能性があります。

テスト目的でイメージを作成する場合は、

-rオプションを指定して、ファイルシステム自体と同じサイズのスパースファイルを作成します。その後、e2fsckは作成されたファイルで直接操作できます。# e2image -r block-device image-file診断用にアーカイブまたは提供するイメージを作成する場合は、

-Qオプションを使用して、転送に適したよりコンパクトなファイル形式を作成します。# e2image -Q block-device image-file

ファイルシステムを再マウントしてログを再生します。

# mount file-system # umount file-system

ファイルシステムを自動的に修復します。ユーザーの介入が必要な場合は、

e2fsckが出力の未修正の問題を示し、このステータスを終了コードに反映させます。# e2fsck -p block-device関連情報

-

システム上の

e2image(8)man ページ -

システム上の

e2fsck(8)man ページ

-

システム上の

第16章 ファイルシステムのマウント

システム管理者は、システムにファイルシステムをマウントすると、ファイルシステムのデータにアクセスできます。

16.1. Linux のマウントメカニズム

以下は、Linux でのファイルシステムのマウントに関する基本的な概念です。

Linux、UNIX、および類似のオペレーティングシステムでは、さまざまなパーティションおよびリムーバブルデバイス (CD、DVD、USB フラッシュドライブなど) にあるファイルシステムをディレクトリーツリーの特定のポイント (マウントポイント) に接続して、再度切り離すことができます。ファイルシステムがディレクトリーにマウントされている間は、そのディレクトリーの元の内容にアクセスすることはできません。

Linux では、ファイルシステムがすでに接続されているディレクトリーにファイルシステムをマウントできます。

マウント時には、次の方法でデバイスを識別できます。

-

UUID (universally unique identifier):

UUID=34795a28-ca6d-4fd8-a347-73671d0c19cbなど -

ボリュームラベル -

LABEL=homeなど -

非永続的なブロックデバイスへのフルパス -

/dev/sda3など

デバイス名、目的のディレクトリー、ファイルシステムタイプなど、必要な情報をすべて指定せずに mount コマンドを使用してファイルシステムをマウントすると、mount ユーティリティーは /etc/fstab ファイルの内容を読み取り、指定のファイルシステムが記載されているかどうかを確認します。/etc/fstab ファイルには、選択したファイルシステムがマウントされるデバイス名およびディレクトリーのリスト、ファイルシステムタイプ、およびマウントオプションが含まれます。そのため、/etc/fstab で指定されたファイルシステムをマウントする場合は、以下のコマンド構文で十分です。

マウントポイントによるマウント:

# mount directoryブロックデバイスによるマウント:

# mount device

関連情報

-

システム上の

mount(8)man ページ - UUID などの永続的な命名属性のリストを表示する方法。

16.2. 現在マウントされているファイルシステムのリスト表示

findmnt ユーティリティーを使用して、現在マウントされているすべてのファイルシステムを、コマンドラインでリスト表示します。

手順

マウントされているファイルシステムのリストを表示するには、

findmntユーティリティーを使用します。$ findmntリスト表示されているファイルシステムを、特定のファイルシステムタイプに制限するには、

--typesオプションを追加します。$ findmnt --types fs-type以下に例を示します。

例16.1 XFS ファイルシステムのみを表示

$ findmnt --types xfs TARGET SOURCE FSTYPE OPTIONS / /dev/mapper/luks-5564ed00-6aac-4406-bfb4-c59bf5de48b5 xfs rw,relatime ├─/boot /dev/sda1 xfs rw,relatime └─/home /dev/mapper/luks-9d185660-7537-414d-b727-d92ea036051e xfs rw,relatime

関連情報

-

システム上の

findmnt(8)man ページ

16.3. mount でファイルシステムのマウント

mount ユーティリティーを使用してファイルシステムをマウントします。

前提条件

選択したマウントポイントにファイルシステムがまだマウントされていないことを確認する。

$ findmnt mount-point

手順

特定のファイルシステムを添付する場合は、

mountユーティリティーを使用します。# mount device mount-point例16.2 XFS ファイルシステムのマウント

たとえば、UUID により識別されるローカル XFS ファイルシステムをマウントするには、次のコマンドを実行します。

# mount UUID=ea74bbec-536d-490c-b8d9-5b40bbd7545b /mnt/datamountがファイルシステムタイプを自動的に認識できない場合は、--typesオプションで指定します。# mount --types type device mount-point例16.3 NFS ファイルシステムのマウント

たとえば、リモートの NFS ファイルシステムをマウントするには、次のコマンドを実行します。

# mount --types nfs4 host:/remote-export /mnt/nfs

関連情報

-

システム上の

mount(8)man ページ

16.4. マウントポイントの移動

mount ユーティリティーを使用して、マウントされたファイルシステムのマウントポイントを別のディレクトリーに変更します。

手順

ファイルシステムがマウントされているディレクトリーを変更するには、以下のコマンドを実行します。

# mount --move old-directory new-directory例16.4 ホームファイルシステムの移動

たとえば、

/mnt/userdirs/ディレクトリーにマウントされたファイルシステムを/home/マウントポイントに移動するには、以下のコマンドを実行します。# mount --move /mnt/userdirs /homeファイルシステムが想定どおりに移動したことを確認します。

$ findmnt $ ls old-directory $ ls new-directory

関連情報

-

システム上の

mount(8)man ページ

16.5. umount でファイルシステムのアンマウント

umount ユーティリティーを使用してファイルシステムをアンマウントします。

手順

次のいずれかのコマンドを使用してファイルシステムをアンマウントします。

マウントポイントで行う場合は、以下のコマンドを実行します。

# umount mount-pointデバイスで行う場合は、以下のコマンドを実行します。

# umount device

コマンドが次のようなエラーで失敗した場合は、プロセスがリソースを使用しているため、ファイルシステムが使用中であることを意味します。

umount: /run/media/user/FlashDrive: target is busy.ファイルシステムが使用中の場合は、

fuserユーティリティーを使用して、ファイルシステムにアクセスしているプロセスを特定します。以下に例を示します。$ fuser --mount /run/media/user/FlashDrive /run/media/user/FlashDrive: 18351その後、ファイルシステムを使用しているプロセスを停止し、再度アンマウントを試みます。

16.6. Web コンソールでのファイルシステムのマウントとマウント解除

RHEL システムでパーティションを使用できるようにするには、パーティションにファイルシステムをデバイスとしてマウントする必要があります。

ファイルシステムのマウントを解除することもできます。アンマウントすると RHEL システムはその使用を停止します。ファイルシステムのマウントを解除すると、デバイスを削除 (delete または remove) または再読み込みできるようになります。

前提条件

-

cockpit-storagedパッケージがシステムにインストールされている。

RHEL 9 Web コンソールがインストールされている。

手順は、Web コンソールのインストールおよび有効化 を参照してください。

- ファイルシステムのマウントを解除する場合は、システムがパーティションに保存されているファイル、サービス、またはアプリケーションを使用しないようにする。

手順

RHEL 9 Web コンソールにログインします。

詳細は、Web コンソールへのログイン を参照してください。

- Storage タブをクリックします。

- Storage テーブルで、パーティションを削除するボリュームを選択します。

- GPT partitions セクションで、ファイルシステムをマウントまたはマウント解除するパーティションの横にあるメニューボタン をクリックします。

- または をクリックします。

16.7. 一般的なマウントオプション

次の表に、mount ユーティリティーの最も一般的なオプションを示します。次の構文を使用して、これらのマウントオプションを適用できます。

# mount --options option1,option2,option3 device mount-point| オプション | 説明 |

|---|---|

|

| ファイルシステムで非同期の入出力を可能にします。 |

|

|

|

|

|

オプション |

|

| 特定のファイルシステムでのバイナリーファイルの実行を許可します。 |

|

| イメージをループデバイスとしてマウントします。 |

|

|

デフォルトでは、 |

|

| 特定のファイルシステムでのバイナリーファイルの実行は許可しません。 |

|

| 普通のユーザー (つまり root 以外のユーザー) によるファイルシステムのマウントおよびアンマウントは許可しません。 |

|

| ファイルシステムがすでにマウントされている場合は再度マウントを行います。 |

|

| 読み取り専用でファイルシステムをマウントします。 |

|

| ファイルシステムを読み取りと書き込み両方でマウントします。 |

|

| 普通のユーザー (つまり root 以外のユーザー) によるファイルシステムのマウントおよびアンマウントを許可します。 |

第17章 複数のマウントポイントでのマウント共有

システム管理者は、マウントポイントを複製して、複数のディレクトリーからファイルシステムにアクセスするようにできます。

17.2. プライベートマウントポイントの複製の作成

マウントポイントをプライベートマウントとして複製します。複製後に、複製または元のマウントポイントにマウントするファイルシステムは、他方のマウントポイントには反映されません。

手順

元のマウントポイントから仮想ファイルシステム (VFS) ノードを作成します。

# mount --bind original-dir original-dir元のマウントポイントをプライベートとしてマークします。

# mount --make-private original-dirあるいは、選択したマウントポイントと、その下のすべてのマウントポイントのマウントタイプを変更するには、

--make-privateではなく、--make-rprivateオプションを使用します。複製を作成します。

# mount --bind original-dir duplicate-dir

例17.1 プライベートマウントポイントとして /mnt に /media を複製

/mediaディレクトリーから VFS ノードを作成します。# mount --bind /media /media/mediaディレクトリーをプライベートとしてマークします。# mount --make-private /mediaそのコピーを

/mntに作成します。# mount --bind /media /mntこれで、

/mediaと/mntはコンテンツを共有してますが、/media内のマウントはいずれも/mntに現れていないことが確認できます。たとえば、CD-ROM ドライブに空でないメディアがあり、/media/cdrom/ディレクトリーが存在する場合は、以下のコマンドを実行します。# mount /dev/cdrom /media/cdrom # ls /media/cdrom EFI GPL isolinux LiveOS # ls /mnt/cdrom #

また、

/mntディレクトリーにマウントされているファイルシステムが/mediaに反映されていないことを確認することもできます。たとえば、/dev/sdc1デバイスを使用する、空でない USB フラッシュドライブをプラグインしており、/mnt/flashdisk/ディレクトリーが存在する場合は、次のコマンドを実行します。# mount /dev/sdc1 /mnt/flashdisk # ls /media/flashdisk # ls /mnt/flashdisk en-US publican.cfg

関連情報

-

システム上の

mount(8)man ページ

17.4. スレーブマウントポイントの複製の作成

マウントポイントを slave マウントタイプとして複製します。複製後に、元のマウントポイントにマウントしたファイルシステムは複製に反映されますが、その逆は反映されません。

手順

元のマウントポイントから仮想ファイルシステム (VFS) ノードを作成します。

# mount --bind original-dir original-dir元のマウントポイントを共有としてマークします。