ストレージデバイスの管理

ローカルおよびリモートのストレージデバイスの設定と管理

概要

- 要件に従ってディスクパーティションを作成します。ディスク暗号化を使用して、ブロックデバイス上のデータを保護します。

- RAID (Redundant Array of Independent Disks) を作成して、複数のドライブにデータを保存し、データ損失を回避します。

- iSCSI および NVMe over Fabric を使用して、ネットワーク経由でストレージにアクセスします。

- 物理ストレージデバイスのプールを管理するように Stratis をセットアップします。

Red Hat ドキュメントへのフィードバック (英語のみ)

Red Hat ドキュメントに関するご意見やご感想をお寄せください。また、改善点があればお知らせください。

Jira からのフィードバック送信 (アカウントが必要)

- Jira の Web サイトにログインします。

- 上部のナビゲーションバーで Create をクリックします。

- Summary フィールドにわかりやすいタイトルを入力します。

- Description フィールドに、ドキュメントの改善に関するご意見を記入してください。ドキュメントの該当部分へのリンクも追加してください。

- ダイアログの下部にある Create をクリックします。

第1章 利用可能なストレージオプションの概要

RHEL 9 では、複数のローカル、リモート、およびクラスターベースのストレージオプションを利用できます。

ローカルストレージは、ストレージデバイスがシステムにインストールされているか、システムに直接接続されていることを意味します。

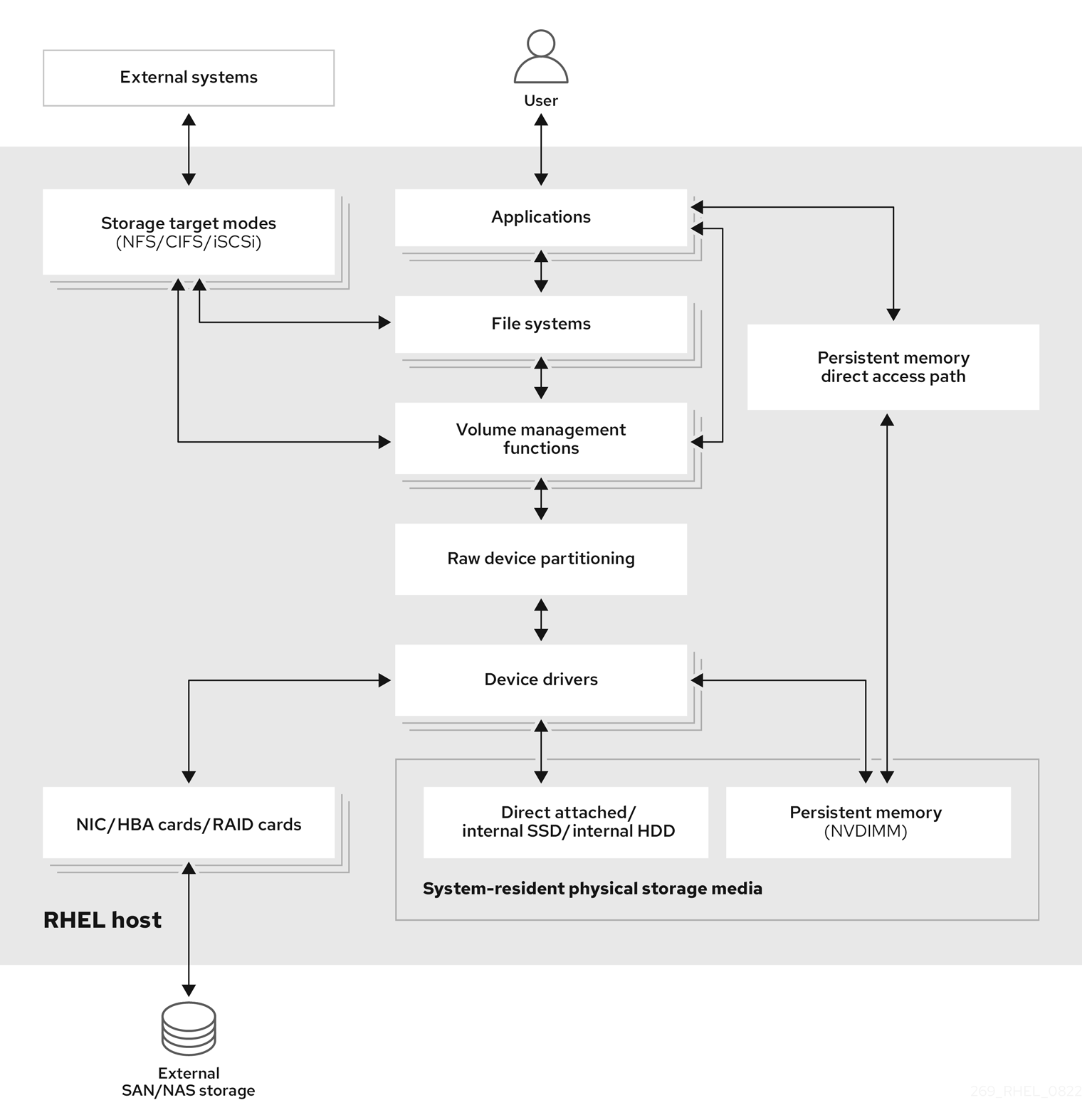

リモートストレージでは、LAN、インターネット、またはファイバーチャネルネットワークを介してデバイスにアクセスします。以下の Red Hat Enterprise Linux ストレージダイアグラムの概要では、さまざまなストレージオプションを説明します。

図1.1 Red Hat Enterprise Linux ストレージダイアグラム (概要)

1.1. ローカルストレージの概要

Red Hat Enterprise Linux 9 は、ローカルストレージオプションを複数提供します。

- 基本的なディスク管理:

partedとfdiskを使用して、ディスクパーティションの作成、変更、削除、および表示を行うことができます。パーティショニングレイアウトの標準は以下のようになります。- マスターブートレコード (MBR)

- BIOS ベースのコンピューターで使用されます。プライマリーパーティション、拡張パーティション、および論理パーティションを作成できます。

- GUID パーティションテーブル (GPT)

- Globally Unique Identifier (GUID) を使用し、一意のディスクおよびパーティション GUID を提供します。

- ストレージ使用オプション

- NVDIMM (Non-Volatile Dual In-line Memory Modules) の管理

- メモリーとストレージの組み合わせです。システムに接続した NVDIMM デバイスで、さまざまな種類のストレージを有効にして管理できます。

- ブロックストレージ管理

- 各ブロックに固有の識別子を持つブロックの形式でデータを保存します。

- ファイルストレージ

- データは、ローカルシステムのファイルレベルに保存されます。これらのデータは、XFS (デフォルト) または ext4 を使用してローカルでアクセスしたり、NFS と SMB を使用してネットワーク上でアクセスできます。

- 論理ボリューム

- 論理ボリュームマネージャー (LVM)

- 物理デバイスから論理デバイスを作成します。論理ボリューム (LV) は、物理ボリューム (PV) とボリュームグループ (VG) の組み合わせです。

- VDO (Virtual Data Optimizer)

重複排除、圧縮、およびシンプロビジョニングを使用して、データの削減に使用されます。VDO の下で論理ボリュームを使用すると、次のことができます。

- VDO ボリュームの拡張

- 複数のデバイスにまたがる VDO ボリューム

- ローカルファイルシステム

- XFS

- デフォルトの RHEL ファイルシステム。

- Ext4

- レガシーファイルシステム。

- Stratis

- Stratis は、高度なストレージ機能に対応する、ユーザーとカーネルのハイブリッドローカルストレージ管理システムです。

1.2. リモートストレージの概要

RHEL 9 で利用可能なリモートストレージオプションは次のとおりです。

- ストレージの接続オプション

- iSCSI

- RHEL 9 は targetcli ツールを使用して、iSCSI ストレージの相互接続を追加、削除、表示、および監視します。

- ファイバーチャネル (FC)

RHEL 9 は、以下のネイティブファイバーチャネルドライバーを提供します。

-

lpfc -

qla2xxx -

Zfcp

-

- NVMe (Non-volatile Memory Express)

ホストソフトウェアユーティリティーがソリッドステートドライブと通信できるようにするインターフェイス。次の種類はファブリックトランスポートを使用して、NVMe over fabrics を設定します。

- RDMA (Remote Direct Memory Access) を使用する NVMe over fabrics

- ファイバーチャネル (FC) を使用した NVMe over fabrics

- Device Mapper Multipath (DM Multipath)

- サーバーノードとストレージアレイ間の複数の I/O パスを 1 つのデバイスに設定できます。これらの I/O パスは、個別のケーブル、スイッチ、コントローラーを含むことができる物理的な SAN 接続です。

- ネットワークファイルシステム

- NFS

- SMB

1.3. GFS2 ファイルシステムの概要

Red Hat Global File System 2 (GFS2) ファイルシステムは、64 ビットの対称クラスターファイルシステムで、共有名前空間を提供し、一般的なブロックデバイスを共有する複数のノード間の一貫性を管理します。GFS2 ファイルシステムは、ローカルファイルシステムに可能な限り近い機能セットを提供すると同時に、ノード間でクラスターの完全な整合性を強制することを目的としています。これを実現するため、ノードはファイルシステムリソースにクラスター全体のロックスキームを使用します。このロックスキームは、TCP/IP などの通信プロトコルを使用して、ロック情報を交換します。

場合によっては、Linux ファイルシステム API では、GFS2 のクラスター化された性質を完全に透過的にすることができません。たとえば、GFS2 で POSIX ロックを使用しているプログラムは、GETLK の使用を回避する必要があります。なぜなら、クラスター環境では、プロセス ID が、クラスター内の別のノードに対するものである可能性があるためです。ただし、ほとんどの場合、GFS2 ファイルシステムの機能は、ローカルファイルシステムのものと同じです。

Red Hat Enterprise Linux Resilient Storage Add-On は GFS2 を提供します。GFS2 が必要とするクラスター管理の提供は Red Hat Enterprise Linux High Availability Add-On により提供されます。

gfs2.ko カーネルモジュールは GFS2 ファイルシステムを実装し、GFS2 クラスターノードに読み込まれます。

GFS2 環境を最大限に利用するためにも、基礎となる設計に起因するパフォーマンス事情を考慮することが重要です。GFS2 では、ローカルファイルシステムと同様、ページキャッシュで、頻繁に使用されるデータのローカルキャッシングを行ってパフォーマンスを向上します。クラスターのノード間で一貫性を維持するために、glock ステートマシンでキャッシュ制御が提供されます。

関連情報

第2章 永続的な命名属性

ストレージデバイスを識別および管理する方法により、システムの安定性と予測可能性が確保されます。RHEL 9 では、この目的のために、従来のデバイス名と永続的な命名属性という 2 つの主要な命名スキームを使用します。

従来のデバイス名

従来のデバイス名は、システム内のデバイスの物理的な場所に基づいて Linux カーネルによって決定されます。たとえば、通常、最初の SATA ドライブには /dev/sda というラベルが付けられ、2 番目の SATA ドライブには /dev/sdb というラベルが付けられます。これらの名前は単純なものですが、デバイスが追加または削除されたとき、またはハードウェア設定が変更されたときに変更される可能性があります。これにより、スクリプトと設定ファイルに問題が生じる可能性があります。さらに、従来の名前には、デバイスの目的や特性についての説明的な情報が欠けています。

永続的な命名属性

永続的な命名属性 (PNA) は、ストレージデバイスの固有の特性に基づいているため、システムの再起動後もストレージデバイスがより安定し、予測可能になります。PNA の実装には、従来の命名と比較してより詳細な初期設定が必要です。PNA の主な利点の 1 つは、ハードウェア設定の変更に対する回復力であり、一貫した命名規則を維持するのに最適であることです。PNA を使用すると、予期しない名前の変更を心配することなく、スクリプト、設定ファイル、管理ツール内でストレージデバイスを参照できます。さらに、PNA にはデバイスの種類や製造元情報などの有用なメタデータが含まれることが多く、効果的なデバイスの識別と管理のための記述性が向上します。

2.1. ファイルシステムとブロックデバイスを識別するための永続属性

RHEL 9 のストレージでは、永続的な命名属性 (PNA) は、システムの再起動、ハードウェアの変更、またはその他のイベント全体にわたってストレージデバイスに一貫した信頼性の高い命名を提供するメカニズムです。これらの属性は、ストレージデバイスが追加、削除、または再設定された場合でも、一貫してストレージデバイスを識別するために使用されます。

PNA はファイルシステムとブロックデバイスの両方を識別するために使用されますが、目的は異なります。

- ファイルシステムを識別するための永続属性

ユニバーサル一意識別子 (UUID)

UUID は主に、ストレージデバイス上のファイルシステムを一意に識別するために使用されます。各ファイルシステムには独自の UUID があり、この識別子は、ファイルシステムがアンマウントされたり、再マウントされたり、デバイスが切り離されて再接続されたりしても、一定のままです。

ラベル

ラベルは、ユーザーがファイルシステムに割り当てた名前です。これらはファイルシステムの識別と参照に使用できますが、UUID ほど標準化されていません。ラベルは、設定ファイルでファイルシステムを指定するための UUID の代替としてよく使用されます。

ファイルシステムにラベルを割り当てると、そのラベルはファイルシステムのメタデータの一部になります。このラベルは、ファイルシステムを別のマウントポイントまたは別のシステムにマウントした場合でも、ファイルシステムとともに存続します。

- ブロックデバイスを識別するための永続属性

ユニバーサル一意識別子 (UUID)

UUID を使用してストレージブロックデバイスを識別できます。ストレージデバイスがフォーマットされるとき、またはストレージデバイス上にファイルシステムが作成されるとき、多くの場合、UUID がデバイス自体に割り当てられます。この UUID はファイルシステムのメタデータまたはパーティションテーブル内に埋め込まれ、永続的なデバイス命名行う際に参照として使用されます。これにより、ファイルシステムを変更したり再フォーマットしたりした場合でも、ブロックデバイスを一意に識別できます。

World Wide Identifier (WWID)

WWID は、ストレージブロックデバイスに関連付けられたグローバルに一意の識別子です。これらは、サーバーを SAN ストレージデバイスに接続するホストバスアダプター (HBA) またはネットワークインターフェイスを識別するために、ファイバーチャネルストレージエリアネットワーク (SAN) で一般的に使用されます。WWID は、サーバーと SAN ストレージデバイス間の一貫した通信を実現し、ストレージデバイスへの冗長パスの管理に役立ちます。

シリアル番号

シリアル番号は、製造元によって各ストレージブロックデバイスに割り当てられる一意の識別子です。これはストレージデバイスを区別するために使用できます。デバイス管理のために UUID や WWID などの他の属性と組み合わせて使用することもできます。

2.2. udev デバイスの命名規則

ユーザー空間デバイスマネージャー (udev) サブシステムを使用して、デバイスに永続的な名前を割り当てるためのルールを定義できます。これらのルールは、/etc/udev/rules.d/ ディレクトリー内の .rules 拡張子が付いたファイルに保存されます。これらのルールの目的は、システムの再起動後や設定の変更後も、ストレージデバイスが一貫して予測どおりに識別されるようにすることです。

udev ルールは、キーと値のペアを使用して人間が判読できる形式で記述されます。デバイスが検出または初期化されると、udev はこれらのルールを定義された順序に基づいて順番に評価します。最初に一致したルールがデバイスに適用され、デバイスの名前とシステム内での識別方法が決定されます。

ストレージデバイスの場合、udev ルールは /dev/disk/ ディレクトリーにシンボリックリンクを作成します。これらのシンボリックリンクはストレージデバイスに使いやすいエイリアスを提供するため、これらのデバイスの参照と管理がより便利になります。

カスタムの udev ルールを作成して、シリアル番号、World Wide Name (WWN) 識別子、その他のデバイス固有の特性などのさまざまな属性に基づいてデバイスに名前を付ける方法を指定できます。特定の命名規則を定義することにより、システム内でデバイスを識別する方法を正確に制御できます。

udev ルールには主に 2 つの場所があります。

-

/lib/udev/rules.d/ディレクトリーには、udevパッケージに付属するデフォルトのルールが含まれています。 -

/etc/udev/rules.dディレクトリーはカスタムudevルール用です。

udev ルールは非常に柔軟ですが、udev の制限事項に注意することが重要です。

-

アクセス可能なタイミング: 一部のストレージデバイスは、

udevクエリー時にアクセスできない場合があります。 -

イベントベースの処理: カーネルはいつでも

udevイベントを送信できます。そのため、デバイスがアクセスできない場合は、ルール処理とリンクの削除をトリガーする可能性があります。 - 処理の遅延: 特に多数のデバイスがある場合、イベントの生成と処理の間に遅延が発生する可能性があります。これにより、カーネルがデバイスを検出してからリンクが利用可能になるまでに遅れが生じます。

-

デバイスのアクセシビリティー:

udevルールによって呼び出される外部プログラム (blkidなど) がデバイスを一時的に開き、他のタスクからデバイスに一時的にアクセスできなくなる可能性があります。 -

リンクの更新:

/dev/disk/でudevによって管理されるデバイス名は、メジャーリリース間で変更される可能性があります。その場合、リンクの更新が必要になります。

関連情報

-

システム上の

udevman ページ

第3章 ディスクパーティション

ディスクを 1 つ以上の論理領域に分割するには、ディスクのパーティション設定ユーティリティーを使用します。これにより、各パーティションを個別に管理できます。

3.1. パーティションの概要

ハードディスクは、パーティションテーブルの各ディスクパーティションの場所とサイズに関する情報を保存します。オペレーティングシステムは、パーティションテーブルの情報を使用して、各パーティションを論理ディスクとして扱います。ディスクパーティション設定には、次のような利点があります。

- 物理ボリュームの管理上の見落としの可能性を減らす。

- 十分なバックアップを確保する。

- 効率的なディスク管理を提供する。

関連情報

- 直接または LVM を間に入れて、LUN でパーティション設定を使用するメリットとデメリットは何ですか ?(Red Hat ナレッジベース)

3.2. パーティションテーブルの種類の比較

デバイスでパーティションを有効にするには、さまざまな種類のパーティションテーブルでブロックデバイスをフォーマットします。次の表では、ブロックデバイスで作成できるさまざまな種類のパーティションテーブルのプロパティーを比較しています。

このセクションでは、IBM Z アーキテクチャーに固有の DASD パーティションテーブルを説明しません。

| パーティションテーブル | パーティションの最大数 | パーティションの最大サイズ |

|---|---|---|

| マスターブートレコード (MBR) | 4 つのプライマリーパーティション、または 3 つのプライマリーパーティションと 12 の論理パーティションを持つ 1 つの拡張パーティション |

512 b セクターのドライブを使用する場合は 2 TiB |

| GUID パーティションテーブル (GPT) | 128 |

512 b セクターのドライブを使用する場合は 8 ZiB |

3.3. MBR ディスクパーティション

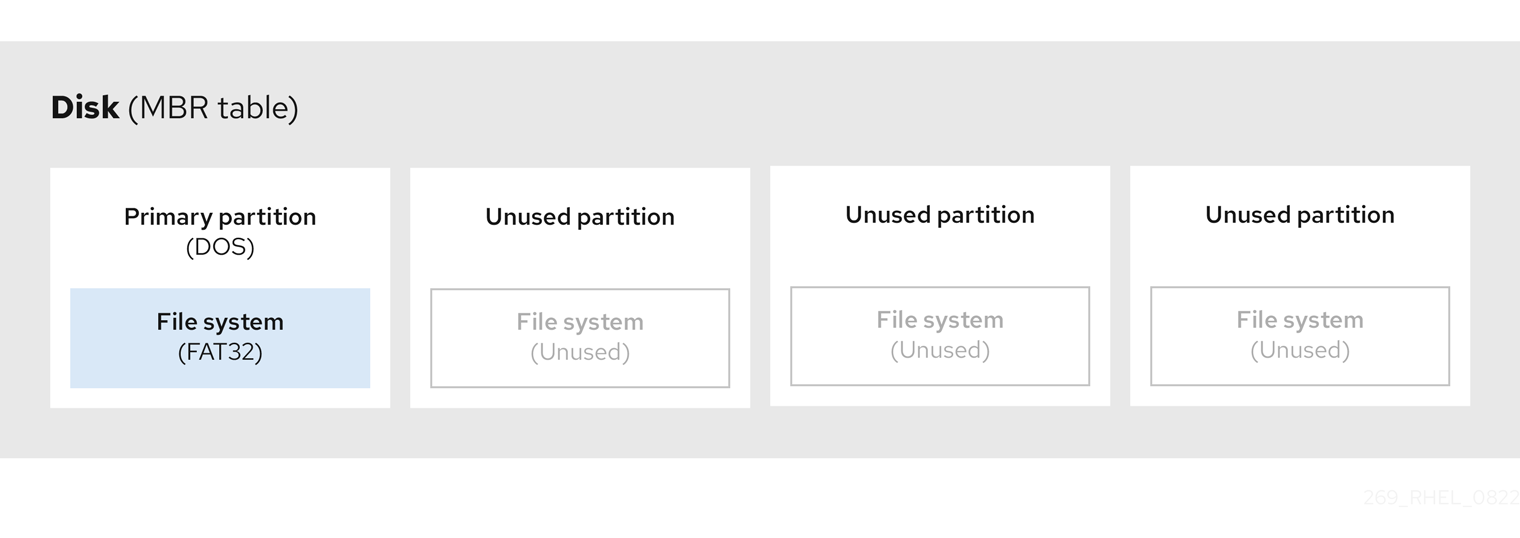

パーティションテーブルはそのディスクの先頭部分となる、他のファイルシステムまたはユーザーデータの前に格納されています。わかりやすくするために、次の図ではパーティションテーブルを区切って示しています。

図3.1 MBR パーティションテーブルがあるディスク

上記の図で示したとおり、パーティションテーブルは使用していない 4 つのプライマリーパーティションの 4 つのセクションに分けられます。プライマリーパーティションは、論理ディスクドライブ (またはセクション) を 1 つだけ含むハードドライブのパーティションです。各論理ドライブは、1 つのパーティションの定義に必要な情報を保持できます。つまり、パーティションテーブルで定義できるプライマリーパーティションは 4 つまでです。

各パーティションテーブルエントリーには、パーティションの重要な特徴が含まれています。

- ディスク上のパーティションの開始点と終了点

-

パーティションの状態 (

アクティブとしてフラグを立てることができるのは 1 つのパーティションのみ) - パーティションのタイプ

開始点と終了点は、ディスク上のパーティションのサイズと場所を定義します。一部のオペレーティングシステムブートローダーは、active フラグを使用します。つまり、"active" とマークされているパーティションのオペレーティングシステムが起動します。

タイプとは、パーティションの用途を識別する番号です。一部のオペレーティングシステムでは、パーティションの種類を使用して以下を行います。

- 特定のファイルシステムタイプを示します。

- 特定のオペレーティングシステムに関連付けられているパーティションにフラグを付けます。

- パーティションに起動可能なオペレーティングシステムが含まれていることを示します。

以下の図は、パーティションが 1 つあるドライブの例を示しています。この例では、最初のパーティションには DOS パーティションタイプのラベルが付けられています。

図3.2 1 つのパーティションを持つディスク

関連情報

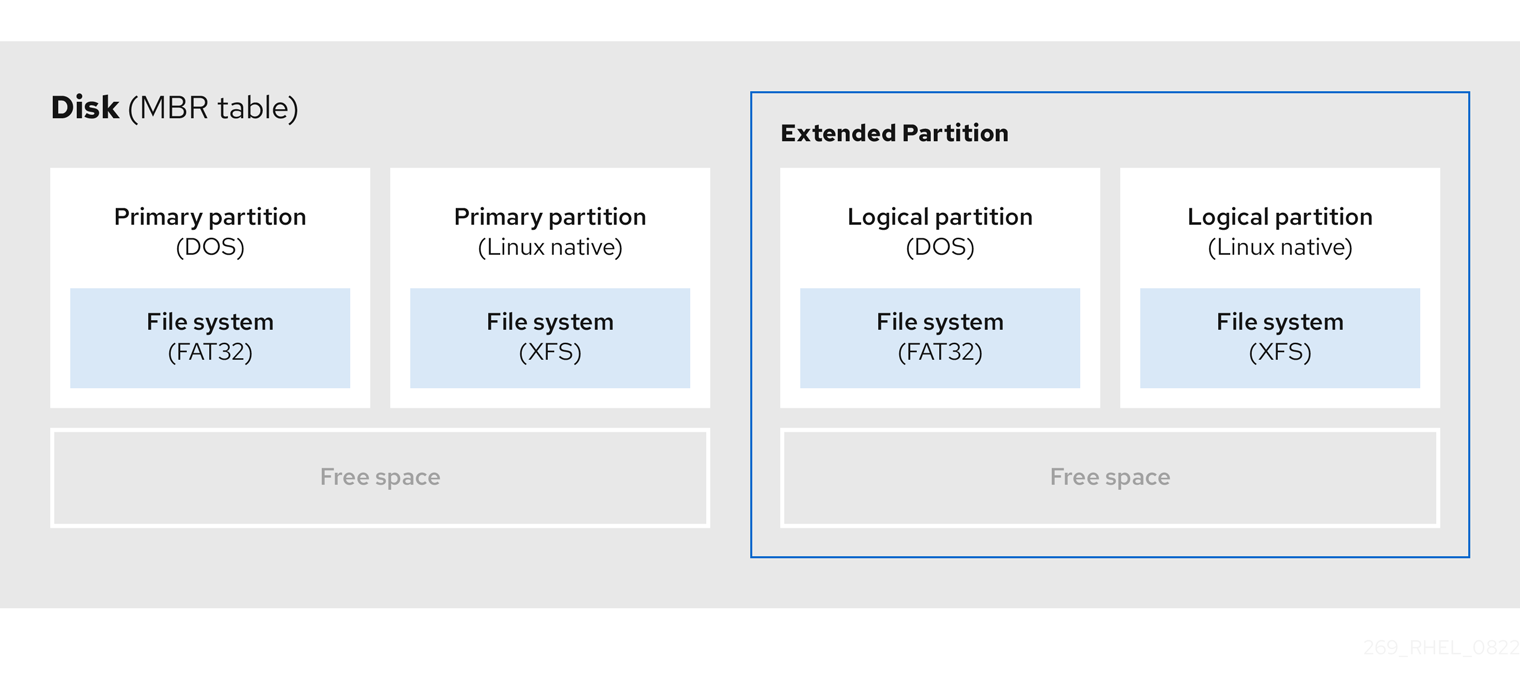

3.4. 拡張 MBR パーティション

必要があれば、タイプを extended に設定して追加のパーティションを作成します。

拡張パーティションは、ディスクドライブに似ています。拡張パーティション内に完全に含まれる 1 つ以上の論理パーティションを指す独自のパーティションテーブルがあります。次の図は、2 つのプライマリーパーティションと、2 つの論理パーティションを含む 1 つの拡張パーティションおよびいくつかの未パーティションの空き領域を備えたディスクドライブを示しています。

図3.3 2 つのプライマリーパーティションと拡張 MBR パーティションの両方を備えたディスク

最大 4 つのプライマリーパーティションと拡張パーティションのみを使用できますが、論理パーティションの数に制限はありません。パーティションにアクセスする場合の Linux の制限として、1 つのディスクドライブで最大 15 の論理パーティションが許可されます。

3.5. MBR パーティションタイプ

次の表は、最も一般的に使用される MBR パーティションタイプとそれらを表す 16 進数のリストです。

| MBR パーティションタイプ | 値 | MBR パーティションタイプ | 値 |

| Empty | 00 | Novell Netware 386 | 65 |

| DOS 12 ビット FAT | 01 | PIC/IX | 75 |

| XENIX root | O2 | 旧 MINIX | 80 |

| XENIX usr | O3 | Linux/MINUX | 81 |

| DOS 16 ビット (32M 以下) | 04 | Linux swap | 82 |

| Extended | 05 | Linux ネイティブ | 83 |

| DOS 16 ビット (32 以上) | 06 | Linux 拡張 | 85 |

| OS/2 HPFS | 07 | Amoeba | 93 |

| AIX | 08 | Amoeba BBT | 94 |

| AIX ブート可能 | 09 | BSD/386 | a5 |

| OS/2 Boot Manager | 0a | OpenBSD | a6 |

| Win95 FAT32 | 0b | NEXTSTEP | a7 |

| Win95 FAT32 (LBA) | 0c | BSDI fs | b7 |

| Win95 FAT16 (LBA) | 0e | BSDI swap | b8 |

| Win95 Extended (LBA) | 0f | Syrinx | c7 |

| Venix 80286 | 40 | CP/M | db |

| Novell | 51 | DOS アクセス | e1 |

| PRep Boot | 41 | DOS R/O | e3 |

| GNU HURD | 63 | DOS セカンダリー | f2 |

| Novell Netware 286 | 64 | BBT | ff |

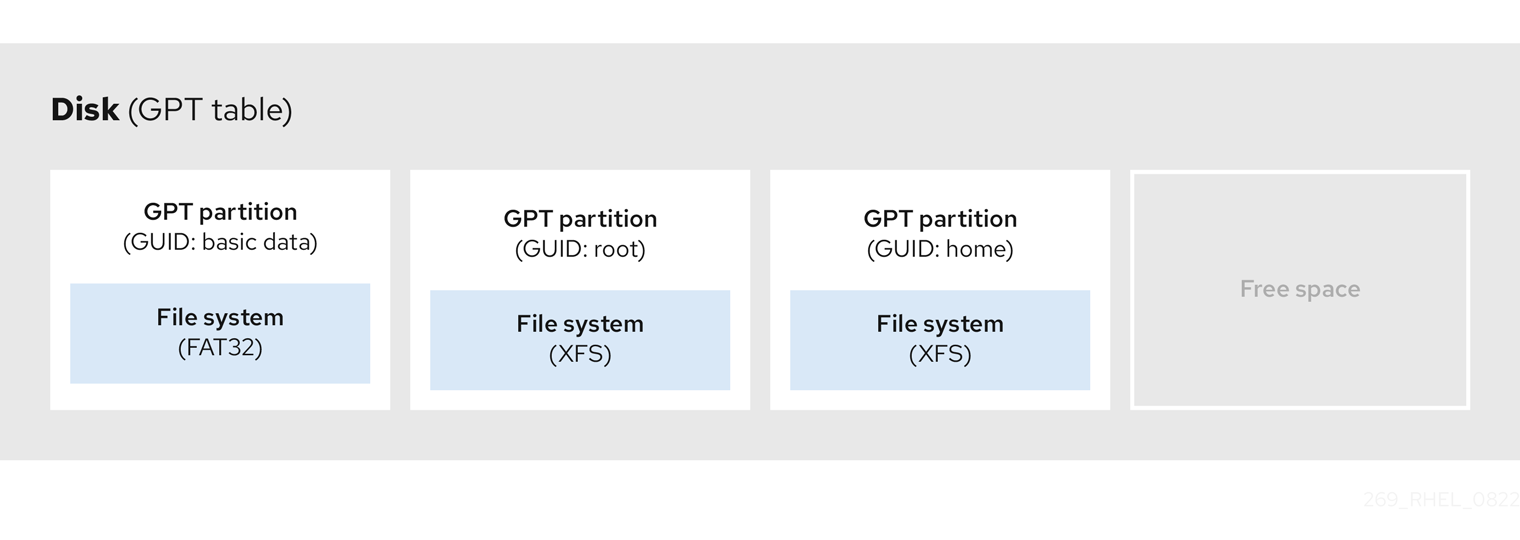

3.6. GUID パーティションテーブル

GUID パーティションテーブル (GPT) は、Globally Unique Identifier (GUID) に基づくパーティション設定スキームです。

GPT は、Mater Boot Record (MBR) パーティションテーブルの制限に対処します。MBR パーティションテーブルは、約 2.2 TB に相当する 2 TiB を超えるストレージに対応できません。代わりに、GPT は大容量のハードディスクをサポートします。アドレス指定可能な最大ディスクサイズは、512b セクタードライブを使用する場合は 8 ZiB、4096b セクタードライブを使用する場合は 64 ZiB です。さらに、デフォルトで、GPT は最大 128 のプライマリーパーティションの作成をサポートします。パーティションテーブルにより多くの領域を割り当てて、プライマリーパーティションの最大量を拡張します。

GPT には GUID に基づくパーティションタイプがあります。特定のパーティションには特定の GUID が必要です。たとえば、Extensible Firmware Interface (EFI) ブートローダーのシステムパーティションには、GUID C12A7328-F81F-11D2-BA4B-00A0C93EC93B が必要です。

GPT ディスクは、論理ブロックアドレス指定 (LBA) とパーティションレイアウトを以下のように使用します。

- MBR ディスクとの下位互換性のために、システムは MBR データ用に GPT の最初のセクター (LBA 0) を予約し、"protective MBR" という名前を適用します。

プライマリー GPT

- ヘッダーは、デバイスの 2 番目の論理ブロック (LBA 1) から始まります。ヘッダーには、ディスク GUID、プライマリーパーティションテーブルの場所、セカンダリー GPT ヘッダーの場所、および CRC32 チェックサム、およびプライマリーパーティションテーブルが含まれます。また、テーブルにあるパーティションエントリーの数も指定します。

- デフォルトでは、プライマリー GPT には 128 のパーティションエントリーが含まれます。各パーティションには、128 バイトのエントリーサイズ、パーティションタイプ GUID、一意のパーティション GUID があります。

セカンダリー GPT

- リカバリーの場合は、プライマリーパーティションテーブルが破損した場合にバックアップテーブルとして役立ちます。

- ディスクの最後の論理セクターにはセカンダリー GPT ヘッダーが含まれており、プライマリーヘッダーが破損した場合に備えて GPT 情報を回復します。

以下が含まれます。

- ディスク GUID

- セカンダリーパーティションテーブルとプライマリー GPT ヘッダーの場所

- それ自体の CRC32 チェックサム

- セカンダリーパーティションテーブル

- 可能なパーティションエントリーの数

図3.4 GUID パーティションテーブルを含むディスク

GPT ディスクにブートローダーを正常にインストールするには、BIOS ブートパーティションが存在する必要があります。ディスクにすでに BIOS ブートパーティションが含まれている場合にのみ、再利用が可能です。これには、Anaconda インストールプログラムによって初期化されたディスクが含まれます。

3.7. パーティションタイプ

パーティションタイプを管理する方法は複数あります。

-

fdiskユーティリティーは、16 進数コードを指定することで、あらゆる種類のパーティションタイプに対応します。 -

systemd-gpt-auto-generatorはユニットジェネレーターユーティリティーで、パーティションタイプを使用してデバイスを自動的に識別し、マウントします。 partedユーティリティーは、フラグ を使用してパーティションタイプをマップします。partedユーティリティーは、LVM、swap、RAID など、特定のパーティションタイプのみを処理します。partedユーティリティーは、次のフラグの設定をサポートしています。-

boot -

root -

swap -

hidden -

raid -

lvm -

lba -

legacy_boot -

irst -

esp -

palo

-

parted 3.5 を使用する Red Hat Enterprise Linux 9 では、追加のフラグ chromeos_kernel および bls_boot を使用できます。

parted ユーティリティーは、パーティションを作成するときにオプションでファイルシステムタイプ引数を受け付けます。必要な条件のリストについては、parted を使用したパーティションの作成 を参照してください。値を使用して以下を行います。

- MBR にパーティションフラグを設定します。

-

GPT にパーティションの UUID タイプを設定します。たとえば、ファイルシステムタイプの

swap、fat、またはhfsには、異なる GUID が設定されます。デフォルト値は Linux Data GUID です。

この引数では、パーティションのファイルシステムは変更されません。サポート対象フラグと GUID のみ区別します。

次のファイルシステムのタイプがサポートされています。

-

xfs -

ext2 -

ext3 -

ext4 -

fat16 -

fat32 -

hfs -

hfs+ -

linux-swap -

ntfs -

reiserfs

3.8. パーティション命名スキーム

Red Hat Enterprise Linux は、/dev/xxyN 形式のファイル名を持つファイルベースの命名スキームを使用します。

デバイスおよびパーティション名は、以下の構造で構成されています。

/dev/-

すべてのデバイスファイルが含まれるディレクトリーの名前。ハードディスクにはパーティションが含まれるため、すべてのパーティションを表すファイルは

/devにあります。 xx- パーティション名の最初の 2 文字は、パーティションを含むデバイスのタイプを示します。

y-

この文字は、パーティションを含む特定のデバイスを示します。たとえば、

/dev/sdaは最初のハードディスク、/dev/sdbは 2 番目のハードディスクです。ドライブの数が 26 を超えるシステムでは、さらに多くの文字を使用できます (例:/dev/sdaa1)。 N-

最後の文字は、パーティションを表す数字を示します。最初の 4 つのパーティション (プライマリーまたは拡張) のパーティションには、

1から4までの番号が付けられます。論理パーティションは5から始まります。たとえば、/dev/sda3は 1 番目のハードディスクの 3 番目のプライマリーパーティションまたは拡張パーティションで、2 番目のハードディスク上の 2 番目の論理パーティション/dev/sdb6です。ドライブのパーティション番号は、MBR パーティションテーブルにのみ適用されます。N は常にパーティションを意味するものではないことに注意してください。

Red Hat Enterprise Linux が すべて のタイプのディスクパーティションを識別して参照できる場合でも、ファイルシステムを読み取れないため、すべてのパーティションタイプに保存されているデータにアクセスできます。ただし、多くの場合、別のオペレーティングシステム専用のパーティション上にあるデータには問題なくアクセスすることができます。

3.9. マウントポイントとディスクパーティション

Red Hat Enterprise Linux では、各パーティションは、ファイルおよびディレクトリーの単一セットをサポートするのに必要なストレージの一部を形成します。パーティションをマウントすると、指定されたディレクトリー (マウントポイント と呼ばれる) を開始点としてそのパーティションのストレージが利用可能になります。

たとえば、パーティション /dev/sda5 が /usr/ にマウントされている場合、/usr/ 下にあるすべてのファイルとディレクトリーは物理的に /dev/sda5 上に存在することになります。ファイル /usr/share/doc/FAQ/txt/Linux-FAQ は /dev/sda5 にありますが、ファイル /etc/gdm/custom.conf はありません。

また、この例では、/usr/ 以下の 1 つ以上のディレクトリーが他のパーティションのマウントポイントになる可能性もあります。たとえば、/usr/local にマウントされた /dev/sda7 パーティションが含まれる場合、/usr/local/man/whatis は /dev/sda5 ではなく /dev/sda7 にあります。

第4章 パーティションの使用

ディスクパーティション設定を使用して、ディスクを 1 つ以上の論理領域に分割し、各パーティションで個別に作業できるようにします。ハードディスクは、パーティションテーブルの各ディスクパーティションの場所とサイズに関する情報を保存します。このテーブルを使用すると、各パーティションはオペレーティングシステムへの論理ディスクとして表示されます。その後、それらの個々のディスクで読み取りと書き込みを行うことができます。

ブロックデバイスでパーティションを使用する利点と欠点の概要については、Red Hat ナレッジベースソリューション What are the advantages and disadvantages to using partitioning on LUNs, either directly or with LVM in between? を参照してください。

4.1. parted でディスクにパーティションテーブルを作成

parted ユーティリティーを使用して、より簡単にパーティションテーブルでブロックデバイスをフォーマットできます。

パーティションテーブルを使用してブロックデバイスをフォーマットすると、そのデバイスに保存されているすべてのデータが削除されます。

手順

インタラクティブな

partedシェルを起動します。# parted block-deviceデバイスにパーティションテーブルがあるかどうかを確認します。

(parted) printデバイスにパーティションが含まれている場合は、次の手順でパーティションを削除します。

新しいパーティションテーブルを作成します。

(parted) mklabel table-typetable-type を、使用するパーティションテーブルのタイプに置き換えます。

-

msdos(MBR の場合) -

gpt(GPT の場合)

-

例4.1 GUID パーティションテーブル (GPT) テーブルの作成

ディスクに GPT テーブルを作成するには、次のコマンドを使用します。

(parted) mklabel gptこのコマンドを入力すると、変更の適用が開始されます。

パーティションテーブルを表示して、作成されたことを確認します。

(parted) printpartedシェルを終了します。(parted) quit

関連情報

-

システム上の

parted(8)man ページ

4.2. parted でパーティションテーブルの表示

ブロックデバイスのパーティションテーブルを表示して、パーティションレイアウトと個々のパーティションの詳細を確認します。parted ユーティリティーを使用して、ブロックデバイスのパーティションテーブルを表示できます。

手順

partedユーティリティーを起動します。たとえば、次の出力は、デバイス/dev/sdaをリストします。# parted /dev/sdaパーティションテーブルを表示します。

(parted) print Model: ATA SAMSUNG MZNLN256 (scsi) Disk /dev/sda: 256GB Sector size (logical/physical): 512B/512B Partition Table: msdos Disk Flags: Number Start End Size Type File system Flags 1 1049kB 269MB 268MB primary xfs boot 2 269MB 34.6GB 34.4GB primary 3 34.6GB 45.4GB 10.7GB primary 4 45.4GB 256GB 211GB extended 5 45.4GB 256GB 211GB logicalオプション: 次に調べるデバイスに切り替えます。

(parted) select block-device

print コマンドの出力の詳細は、以下を参照してください。

Model: ATA SAMSUNG MZNLN256 (scsi)- ディスクタイプ、製造元、モデル番号、およびインターフェイス。

Disk /dev/sda: 256GB- ブロックデバイスへのファイルパスとストレージ容量。

Partition Table: msdos- ディスクラベルの種類。

Number-

パーティション番号。たとえば、マイナー番号 1 のパーティションは、

/dev/sda1に対応します。 StartおよびEnd- デバイスにおけるパーティションの開始場所と終了場所。

Type- 有効なタイプは、メタデータ、フリー、プライマリー、拡張、または論理です。

File system-

ファイルシステムの種類。ファイルシステムの種類が不明な場合は、デバイスの

File systemフィールドに値が表示されません。partedユーティリティーは、暗号化されたデバイスのファイルシステムを認識できません。 Flags-

パーティションのフラグ設定リスト。利用可能なフラグは、

boot、root、swap、hidden、raid、lvm、またはlbaです。

関連情報

-

システム上の

parted(8)man ページ

4.3. parted を使用したパーティションの作成

システム管理者は、parted ユーティリティーを使用してディスクに新しいパーティションを作成できます。

必要なパーティションは、swap、/boot/、および /(root) です。

前提条件

- ディスクのパーティションテーブル。

- 2TiB を超えるパーティションを作成する場合は、GUID Partition Table (GPT) でディスクをフォーマットしておく。

手順

partedユーティリティーを起動します。# parted block-device現在のパーティションテーブルを表示し、十分な空き領域があるかどうかを確認します。

(parted) print- 十分な空き容量がない場合は、パーティションのサイズを変更してください。

パーティションテーブルから、以下を確認します。

- 新しいパーティションの開始点と終了点

- MBR で、どのパーティションタイプにすべきか

新しいパーティションを作成します。

(parted) mkpart part-type name fs-type start end-

part-type を

primary、logical、またはextendedに置き換えます。これは MBR パーティションテーブルにのみ適用されます。 - name を任意のパーティション名に置き換えます。これは GPT パーティションテーブルに必要です。

-

fs-type を、

xfs、ext2、ext3、ext4、fat16、fat32、hfs、hfs+、linux-swap、ntfs、またはreiserfsに置き換えます。fs-type パラメーターは任意です。partedユーティリティーは、パーティションにファイルシステムを作成しないことに注意してください。 -

start と end を、パーティションの開始点と終了点を決定するサイズに置き換えます (ディスクの開始からカウントします)。

512MiB、20GiB、1.5TiBなどのサイズ接尾辞を使用できます。デフォルトサイズの単位はメガバイトです。

例4.2 小さなプライマリーパーティションの作成

MBR テーブルに 1024MiB から 2048MiB までのプライマリーパーティションを作成するには、次のコマンドを使用します。

(parted) mkpart primary 1024MiB 2048MiBコマンドを入力すると、変更の適用が開始されます。

-

part-type を

パーティションテーブルを表示して、作成されたパーティションのパーティションタイプ、ファイルシステムタイプ、サイズが、パーティションテーブルに正しく表示されていることを確認します。

(parted) printpartedシェルを終了します。(parted) quit新規デバイスノードを登録します。

# udevadm settleカーネルが新しいパーティションを認識していることを確認します。

# cat /proc/partitions

関連情報

-

システム上の

parted(8)man ページ - parted でディスクにパーティションテーブルを作成

- parted でパーティションのサイズ変更

4.4. fdisk でパーティションタイプの設定

fdisk ユーティリティーを使用して、パーティションタイプまたはフラグを設定できます。

前提条件

- ディスク上のパーティション。

手順

インタラクティブな

fdiskシェルを起動します。# fdisk block-device現在のパーティションテーブルを表示して、パーティションのマイナー番号を確認します。

Command (m for help): print現在のパーティションタイプは

Type列で、それに対応するタイプ ID はId列で確認できます。パーティションタイプコマンドを入力し、マイナー番号を使用してパーティションを選択します。

Command (m for help): type Partition number (1,2,3 default 3): 2

オプション: リストを 16 進数コードで表示します。

Hex code (type L to list all codes): Lパーティションタイプを設定します。

Hex code (type L to list all codes): 8e変更を書き込み、

fdiskシェルを終了します。Command (m for help): write The partition table has been altered. Syncing disks.変更を確認します。

# fdisk --list block-device

4.5. parted でパーティションのサイズ変更

parted ユーティリティーを使用して、パーティションを拡張して未使用のディスク領域を利用したり、パーティションを縮小してその容量をさまざまな目的に使用したりできます。

前提条件

- パーティションを縮小する前にデータをバックアップする。

- 2TiB を超えるパーティションを作成する場合は、GUID Partition Table (GPT) でディスクをフォーマットしておく。

- パーティションを縮小する場合は、サイズを変更したパーティションより大きくならないように、最初にファイルシステムを縮小しておく。

XFS は縮小に対応していません。

手順

partedユーティリティーを起動します。# parted block-device現在のパーティションテーブルを表示します。

(parted) printパーティションテーブルから、以下を確認します。

- パーティションのマイナー番号。

- 既存のパーティションの位置とサイズ変更後の新しい終了点。

パーティションのサイズを変更します。

(parted) resizepart 1 2GiB- 1 を、サイズを変更するパーティションのマイナー番号に置き換えます。

-

2 を、サイズを変更するパーティションの新しい終了点を決定するサイズに置き換えます (ディスクの開始からカウントします)。

512MiB、20GiB、1.5TiBなどのサイズ接尾辞を使用できます。デフォルトサイズの単位はメガバイトです。

パーティションテーブルを表示して、サイズ変更したパーティションのサイズが、パーティションテーブルで正しく表示されていることを確認します。

(parted) printpartedシェルを終了します。(parted) quitカーネルが新しいパーティションを登録していることを確認します。

# cat /proc/partitions- オプション: パーティションを拡張した場合は、そこにあるファイルシステムも拡張します。

関連情報

-

システム上の

parted(8)man ページ

4.6. parted でパーティションの削除

parted ユーティリティーを使用すると、ディスクパーティションを削除して、ディスク領域を解放できます。

パーティションを削除すると、そのパーティションに保存されているすべてのデータが削除されます。

手順

インタラクティブな

partedシェルを起動します。# parted block-device-

block-device を、パーティションを削除するデバイスへのパス (例:

/dev/sda) に置き換えます。

-

block-device を、パーティションを削除するデバイスへのパス (例:

現在のパーティションテーブルを表示して、削除するパーティションのマイナー番号を確認します。

(parted) printパーティションを削除します。

(parted) rm minor-number- minor-number を、削除するパーティションのマイナー番号に置き換えます。

このコマンドを実行すると、すぐに変更の適用が開始されます。

パーティションテーブルからパーティションが削除されたことを確認します。

(parted) printpartedシェルを終了します。(parted) quitパーティションが削除されたことをカーネルが登録していることを確認します。

# cat /proc/partitions-

パーティションが存在する場合は、

/etc/fstabファイルからパーティションを削除します。削除したパーティションを宣言している行を見つけ、ファイルから削除します。 システムが新しい

/etc/fstab設定を登録するように、マウントユニットを再生成します。# systemctl daemon-reloadスワップパーティション、または LVM の一部を削除した場合は、カーネルコマンドラインからパーティションへの参照をすべて削除します。

アクティブなカーネルオプションを一覧表示し、削除されたパーティションを参照するオプションがないか確認します。

# grubby --info=ALL削除されたパーティションを参照するカーネルオプションを削除します。

# grubby --update-kernel=ALL --remove-args="option"

アーリーブートシステムに変更を登録するには、

initramfsファイルシステムを再構築します。# dracut --force --verbose

関連情報

-

システム上の

parted(8)man ページ

第5章 ディスクを再設定するストラテジー

ディスクのパーティションを再設定する方法は複数あります。これには以下が含まれます。

- パーティションが分割されていない空き領域が利用できる。

- 未使用のパーティションが利用可能である。

- アクティブに使用されているパーティションの空き領域が利用可能である。

以下の例は、わかりやすくするために単純化されており、実際に Red Hat Enterprise Linux をインストールするときの正確なパーティションレイアウトは反映していません。

5.1. パーティションが分割されていない空き領域の使用

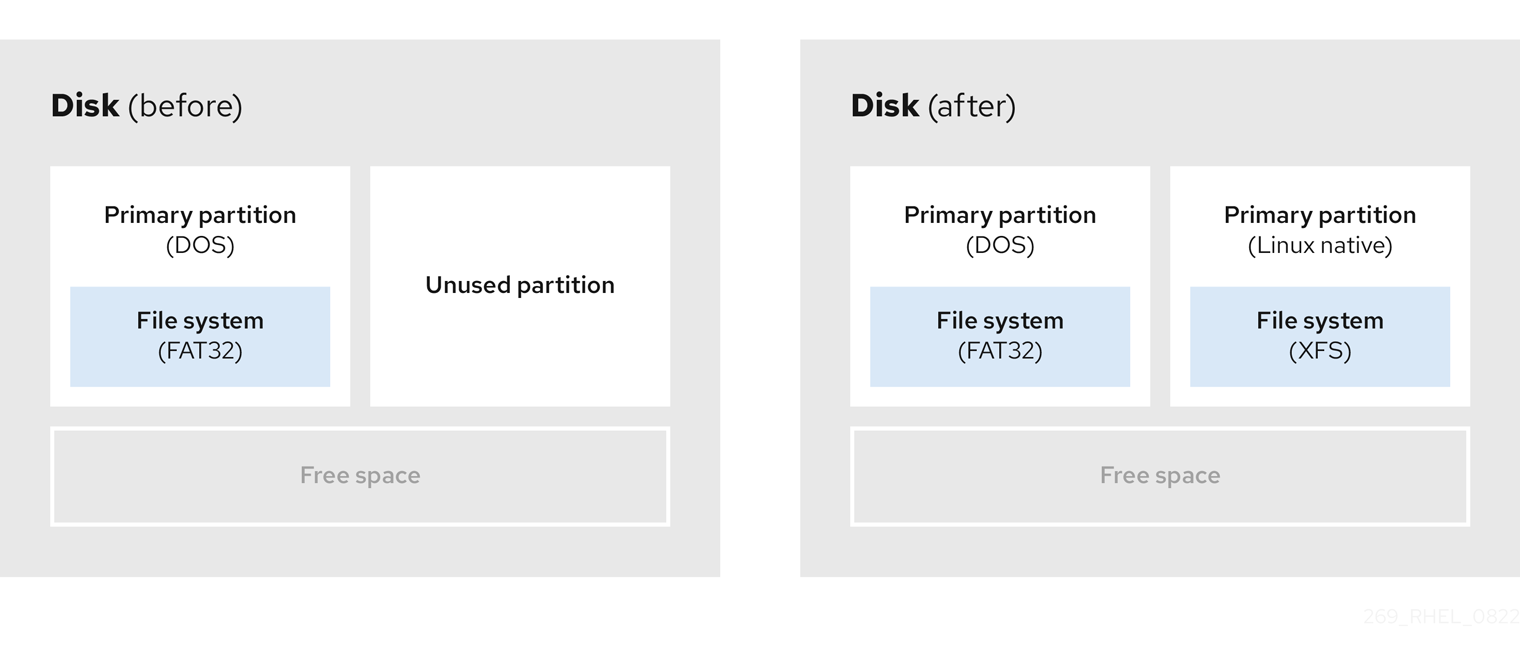

すでに定義されているパーティションはハードディスク全体にまたがらないため、定義されたパーティションには含まれない未割り当ての領域が残されます。次の図は、これがどのようになるかを示しています。

図5.1 パーティションが分割されていない空き領域があるディスク

最初の図は、1 つのプライマリーパーティションと未割り当て領域のある未定義のパーティションを持つディスクを表しています。2 番目の図は、スペースが割り当てられた 2 つの定義済みパーティションを持つディスクを表しています。

未使用のハードディスクもこのカテゴリーに分類されます。唯一の違いは、すべて の領域が定義されたパーティションの一部ではないことです。

新しいディスクでは、未使用の領域から必要なパーティションを作成できます。ほとんどのオペレーティングシステムは、ディスクドライブ上の利用可能な領域をすべて取得するように設定されています。

5.2. 未使用パーティションの領域の使用

次の例の最初の図は、未使用のパーティションを持つディスクを表しています。2 番目の図は、Linux の未使用パーティションの再割り当てを表しています。

図5.2 未使用のパーティションがあるディスク

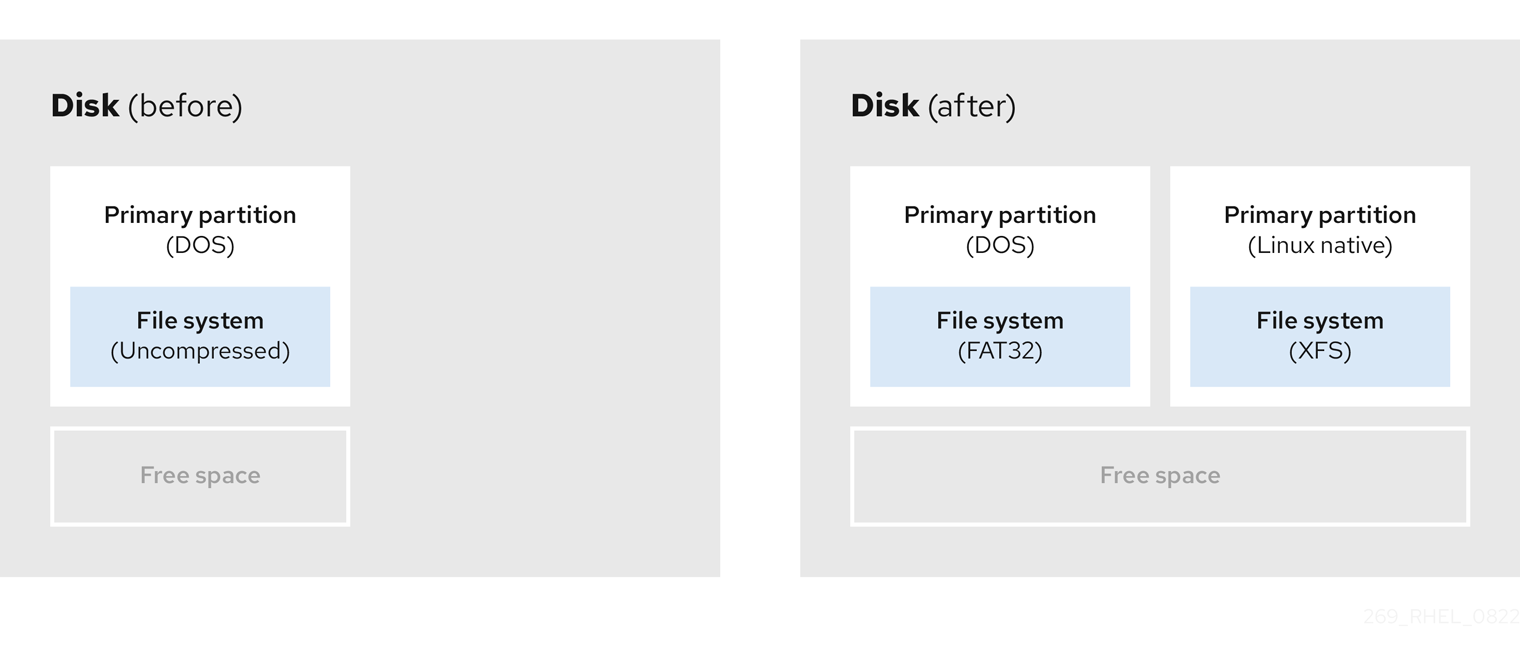

未使用のパーティションに割り当てられた領域を使用するには、パーティションを削除してから、代わりに適切な Linux パーティションを作成します。または、インストールプロセス時に未使用のパーティションを削除し、新しいパーティションを手動で作成します。

5.3. アクティブなパーティションの空き領域の使用

すでに使用されているアクティブなパーティションには、必要な空き領域が含まれているため、このプロセスの管理は困難な場合があります。ほとんどの場合、ソフトウェアが事前にインストールされているコンピューターのハードディスクには、オペレーティングシステムとデータを保持する大きなパーティションが 1 つ含まれます。

アクティブなパーティションでオペレーティングシステム (OS) を使用する場合は、OS を再インストールする必要があります。ソフトウェアが事前にインストールされている一部のコンピューターには、元の OS を再インストールするためのインストールメディアが含まれていないことに注意してください。元のパーティションと OS インストールを破棄する前に、これが OS に当てはまるか確認してください。

使用可能な空き領域の使用を最適化するには、破壊的または非破壊的なパーティション再設定の方法を使用できます。

5.3.1. 破壊的な再設定

破壊的なパーティション再設定は、ハードドライブのパーティションを破棄し、代わりにいくつかの小さなパーティションを作成します。この方法は完全にコンテンツを削除するため、元のパーティションから必要なデータをバックアップします。

既存のオペレーティングシステム用に小規模なパーティションを作成すると、以下が可能になります。

- ソフトウェアをの再インストール。

- データの復元。

- Red Hat Enterprise Linux インストールの開始。

以下の図は、破壊的なパーティション再設定の方法を使用を簡潔に示しています。

図5.3 ディスク上での破壊的な再パーティション処理

このメソッドは、元のパーティションに保存されたデータをすべて削除します。

5.3.2. 非破壊的な再パーティション

非破壊的なパーティション再設定では、データの損失なしにパーティションのサイズを変更します。この方法は信頼性できますが、大きなドライブでは処理に時間がかかります。

以下は、破壊的なパーティション再設定の開始に役立つメソッドのリストです。

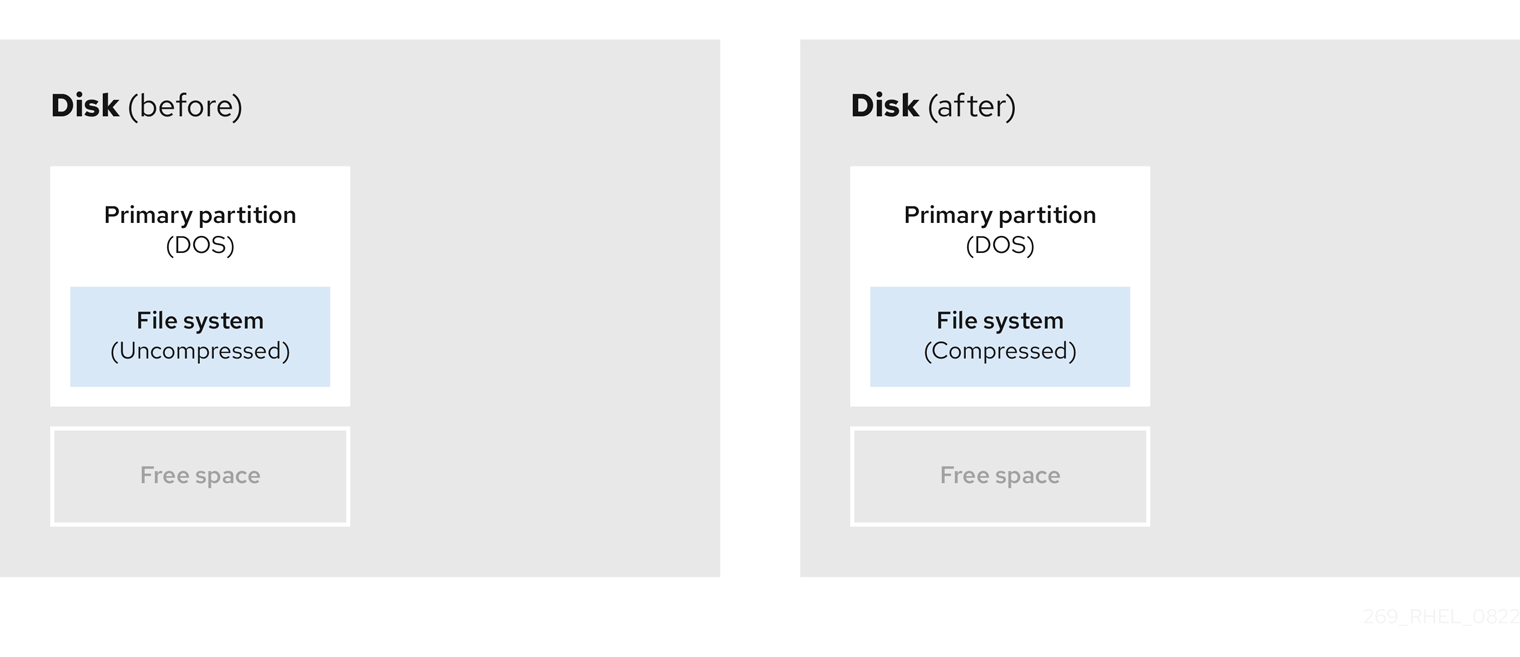

- 既存データの圧縮

一部のデータの保存場所は変更できません。これにより、必要なサイズへのパーティションのサイズ変更が妨げられ、最終的に破壊的なパーティション再設定プロセスが必要になる可能性があります。既存のパーティションでデータを圧縮すると、必要に応じてパーティションのサイズを変更できます。また、使用可能な空き容量を最大化することもできます。

以下の図は、このプロセスを簡略化したものです。

図5.4 ディスク上でのデータ圧縮

データ損失の可能性を回避するには、圧縮プロセスを続行する前にバックアップを作成します。

- 既存パーティションのサイズ変更

既存のパーティションのサイズを変更すると、より多くの領域を解放できます。結果は、サイズ変更ソフトウェアにより異なります。多くの場合、元のパーティションと同じタイプのフォーマットされていない新しいパーティションを作成できます。

サイズ変更後の手順は、使用するソフトウェアにより異なります。以下の例では、新しい DOS (Disk Operating System) パーティションを削除し、代わりに Linux パーティションを作成することを推奨します。サイズ変更プロセスを開始する前に、何がディスクに最適か確認してください。

図5.5 ディスク上でのパーティションのサイズ変更

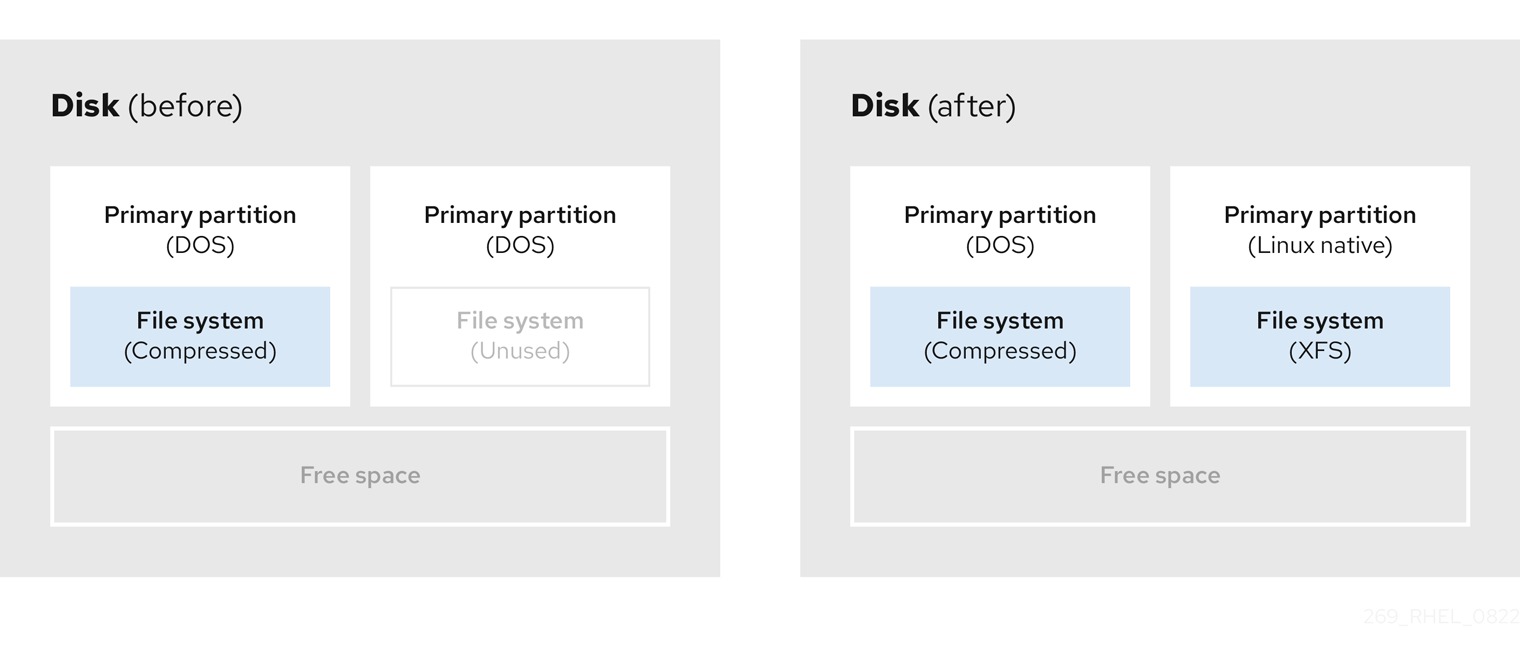

- オプション: 新規パーティションの作成

一部のサイズ変更ソフトウェアは、Linux ベースのシステムをサポートしています。この場合、サイズ変更後に新たに作成されたパーティションを削除する必要はありません。新しいパーティションの作成方法は、使用するソフトウェアによって異なります。

以下の図は、新しいパーティションを作成する前後のディスクの状態を示しています。

図5.6 最終パーティション設定のディスク

第6章 iSCSI ターゲットの設定

Red Hat Enterprise Linux では、コマンドラインインターフェイスとして targetcli シェルを使用し、以下の操作を行います。

- iSCSI ハードウェアを使用できるように iSCSI ストレージ相互接続を追加、削除、表示、監視します。

- ファイル、ボリューム、ローカル SCSI デバイス、またはリモートシステムへの RAM ディスクで対応しているローカルストレージリソースをエクスポートします。

targetcli ツールには、組み込みタブ補完、自動補完サポート、インラインドキュメントなどのツリーベースのレイアウトがあります。

6.1. targetcli のインストール

targetcli ツールをインストールして、iSCSI ストレージの相互接続を追加、監視、削除します。

手順

targetcliツールをインストールします。# dnf install targetcliターゲットサービスを起動します。

# systemctl start targetシステムの起動時にターゲットサービスが起動するように設定するには、次のコマンドを実行します。

# systemctl enable targetファイアウォールの

3260ポートを開き、ファイアウォール設定を再読み込みします。# firewall-cmd --permanent --add-port=3260/tcp Success# firewall-cmd --reload Success

検証

targetcliレイアウトを表示します。# targetcli /> ls o- /........................................[...] o- backstores.............................[...] | o- block.................[Storage Objects: 0] | o- fileio................[Storage Objects: 0] | o- pscsi.................[Storage Objects: 0] | o- ramdisk...............[Storage Objects: 0] o- iscsi...........................[Targets: 0] o- loopback........................[Targets: 0]

関連情報

-

システム上の

targetcli(8)man ページ

6.2. iSCSI ターゲットの作成

iSCSI ターゲットを作成すると、クライアントの iSCSI イニシエーターがサーバー上のストレージデバイスにアクセスできるようになります。ターゲットとイニシエーターにはどちらも一意の識別名があります。

前提条件

-

targetcliをインストールして、実行している。詳細は、targetcli のインストール を参照してください。

手順

iSCSI ディレクトリーに移動します。

cdコマンドを使用して iSCSI ディレクトリーに移動することもできます。/> iscsi/iSCSI ターゲットを作成するには、以下のいずれかのオプションを使用します。

デフォルトのターゲット名を使用した iSCSI ターゲットの作成:

/iscsi> create Created target iqn.2003-01.org.linux-iscsi.hostname.x8664:sn.78b473f296ff Created TPG1特定の名前を使用した iSCSI ターゲットの作成:

/iscsi> create iqn.2006-04.com.example:444 Created target iqn.2006-04.com.example:444 Created TPG1 Here

iqn.2006-04.com.example:444is target_iqn_nameiqn.2006-04.com.example:444 を、特定のターゲット名に置き換えます。

新たに作成されたターゲットを確認します。

/iscsi> ls o- iscsi.......................................[1 Target] o- iqn.2006-04.com.example:444................[1 TPG] o- tpg1...........................[enabled, auth] o- acls...............................[0 ACL] o- luns...............................[0 LUN] o- portals.........................[0 Portal]

関連情報

-

システム上の

targetcli(8)man ページ

6.3. iSCSI バックストア

iSCSI バックストアは、エクスポートした LUN のデータをローカルマシンに保存するさまざまな方法に対応します。ストレージオブジェクトを作成して、バックストアが使用するリソースを定義します。

管理者は、LIO (Linux-IO) が対応する以下のバックストアデバイスのいずれかを選択できます。

fileioバックストア-

ローカルファイルシステム上の通常のファイルをディスクイメージとして使用する場合は、

fileioストレージオブジェクトを作成します。fileioバックストアの作成については、fileio ストレージオブジェクトの作成 を参照してください。 blockバックストア-

ローカルのブロックデバイスおよび論理デバイスを使用している場合には、

ブロックストレージオブジェクトを作成します。blockバックストアの作成については、ブロックストレージオブジェクトの作成 を参照してください。 pscsiバックストア-

ストレージオブジェクトが SCSI コマンドの直接パススルーに対応している場合は、

pscsiストレージオブジェクトを作成します。pscsiバックストアの作成については、pscsi ストレージオブジェクトの作成 を参照してください。 ramdiskバックストア-

一時的な RAM 対応デバイスを作成する場合は、

ramdiskストレージオブジェクトを作成します。ramdiskバックストアの作成については、メモリーコピーの RAM ディスクストレージオブジェクトの作成 を参照してください。

関連情報

-

システム上の

targetcli(8)man ページ

6.4. fileio ストレージオブジェクトの作成

fileio ストレージオブジェクトは、write_back 操作または write_ thru 操作のいずれかに対応します。write_back 操作では、ローカルファイルシステムキャッシュが有効になります。これにより、パフォーマンスが向上しますが、データの損失のリスクが高まります。

write_thru 操作を優先させるために、write_back=false を使用して write_back 操作を無効にすることが推奨されます。

前提条件

-

targetcliをインストールして、実行している。詳細は、targetcli のインストール を参照してください。

手順

backstores/ディレクトリーからfileio/に移動します。/> backstores/fileiofileioストレージオブジェクトを作成します。/backstores/fileio> create file1 /tmp/disk1.img 200M write_back=false Created fileio file1 with size 209715200

検証

作成された

fileioストレージオブジェクトを確認します。/backstores/fileio> ls

関連情報

-

システム上の

targetcli(8)man ページ

6.5. ブロックストレージオブジェクトの作成

ブロックドライバーを使用すると、/sys/block/ ディレクトリーにあるブロックデバイスを LIO (Linux-IO) で使用できます。これには、HDD、SSD、CD、DVD などの物理デバイス、およびソフトウェアやハードウェアの RAID ボリューム、LVM ボリュームなどの論理デバイスが含まれます。

前提条件

-

targetcliをインストールして、実行している。詳細は、targetcli のインストール を参照してください。

手順

backstores/ディレクトリーからblock/に移動します。/> backstores/block/blockバックストアを作成します。/backstores/block> create name=block_backend dev=/dev/sdb Generating a wwn serial. Created block storage object block_backend using /dev/vdb.

検証

作成された

blockストレージオブジェクトを確認します。/backstores/block> ls

関連情報

-

システム上の

targetcli(8)man ページ

6.6. pscsi ストレージオブジェクトの作成

SCSI エミュレーションなしで SCSI コマンドの直接パススルーに対応するストレージオブジェクト、および /proc/scsi/scsi に lsscsi とともに表示される基盤の SCSI デバイス (SAS ハードドライブなど) で SCSI コマンドの直接パススルーに対応するストレージオブジェクトは、バックストアとして設定できます。このサブシステムでは、SCSI-3 以降に対応しています。

pscsi は、上級ユーザーのみが使用してください。非対称論理ユニット割り当て (ALUA) や永続予約 (VMware ESX や vSphere で使用される永続予約など) は、通常はデバイスのファームウェアに実装されず、誤作動やクラッシュが発生する原因となることがあります。確信が持てない場合は、実稼働の設定に block バックストアを使用してください。

前提条件

-

targetcliをインストールして、実行している。詳細は、targetcli のインストール を参照してください。

手順

backstores/ディレクトリーからpscsi/に移動します。/> backstores/pscsi/この例では、

/dev/sr0を使用して物理 SCSI デバイスである TYPE_ROM デバイスのpscsiバックストアを作成します。/backstores/pscsi> create name=pscsi_backend dev=/dev/sr0 Generating a wwn serial. Created pscsi storage object pscsi_backend using /dev/sr0

検証

作成した

pscsiストレージオブジェクトを確認します。/backstores/pscsi> ls

関連情報

-

システム上の

targetcli(8)man ページ

6.7. メモリーコピーの RAM ディスクストレージオブジェクトの作成

メモリーコピー RAM ディスク (ramdisk) は、完全な SCSI エミュレーションと、イニシエーターのメモリーコピーを使用した個別のメモリーマッピングが含まれる RAM ディスクを提供します。これにより、マルチセッションの機能を利用できます。これは、特に実稼働環境での高速で不揮発性の大容量ストレージで有用です。

前提条件

-

targetcliをインストールして、実行している。詳細は、targetcli のインストール を参照してください。

手順

backstores/ディレクトリーからramdisk/に移動します。/> backstores/ramdisk/1GB RAM ディスクバックストアを作成します。

/backstores/ramdisk> create name=rd_backend size=1GB Generating a wwn serial. Created rd_mcp ramdisk rd_backend with size 1GB.

検証

作成した

ramdiskストレージオブジェクトを確認します。/backstores/ramdisk> ls

関連情報

-

システム上の

targetcli(8)man ページ

6.8. iSCSI ポータルの作成

iSCSI ポータルを作成できます。これにより、IP アドレスとポートがターゲットに追加され、ターゲットが有効な状態に維持されます。

前提条件

-

targetcliをインストールして、実行している。詳細は、targetcli のインストール を参照してください。 - ターゲットポータルグループ (TPG) に関連付けられた iSCSI ターゲット。詳細は、iSCSI ターゲットの作成 を参照してください。

手順

TPG ディレクトリーに移動します。

/iscsi> iqn.2006-04.example:444/tpg1/iSCSI ポータルを作成するには、以下のいずれかのオプションを使用します。

デフォルトポータルを作成するには、デフォルトの iSCSI ポート

3260を使用し、ターゲットがそのポートのすべての IP アドレスをリッスンできるようにします。/iscsi/iqn.20...mple:444/tpg1> portals/ create Using default IP port 3260 Binding to INADDR_Any (0.0.0.0) Created network portal 0.0.0.0:3260

特定の IP アドレスを使用したポータルの作成:

/iscsi/iqn.20...mple:444/tpg1> portals/ create 192.168.122.137 Using default IP port 3260 Created network portal 192.168.122.137:3260

検証

新たに作成されたポータルを確認します。

/iscsi/iqn.20...mple:444/tpg1> ls o- tpg.................................. [enambled, auth] o- acls ......................................[0 ACL] o- luns ......................................[0 LUN] o- portals ................................[1 Portal] o- 192.168.122.137:3260......................[OK]

関連情報

-

システム上の

targetcli(8)man ページ

6.9. iSCSI LUN の作成

論理ユニット番号 (LUN) は、iSCSI バックストアで対応している物理デバイスです。各 LUN には固有の番号があります。

前提条件

-

targetcliをインストールして、実行している。詳細は、targetcli のインストール を参照してください。 - ターゲットポータルグループ (TPG) に関連付けられた iSCSI ターゲット。詳細は、iSCSI ターゲットの作成 を参照してください。

- 作成したストレージオブジェクト。詳細は、iSCSI バックストア を参照してください。

手順

作成したストレージオブジェクトの LUN を作成します。

/iscsi/iqn.20...mple:444/tpg1> luns/ create /backstores/ramdisk/rd_backend Created LUN 0. /iscsi/iqn.20...mple:444/tpg1> luns/ create /backstores/block/block_backend Created LUN 1. /iscsi/iqn.20...mple:444/tpg1> luns/ create /backstores/fileio/file1 Created LUN 2.

作成した LUN を確認します。

/iscsi/iqn.20...mple:444/tpg1> ls o- tpg.................................. [enambled, auth] o- acls ......................................[0 ACL] o- luns .....................................[3 LUNs] | o- lun0.........................[ramdisk/ramdisk1] | o- lun1.................[block/block1 (/dev/vdb1)] | o- lun2...................[fileio/file1 (/foo.img)] o- portals ................................[1 Portal] o- 192.168.122.137:3260......................[OK]デフォルトの LUN 名は

0から始まります。重要デフォルトでは、読み書きパーミッションを持つ LUN が作成されます。ACL の作成後に新しい LUN が追加されると、LUN は自動的に利用可能なすべての ACL にマッピングされ、セキュリティー上のリスクが発生します。読み取り専用権限を持つ LUN の作成については、Creating a read-only iSCSI LUN を参照してください。

- ACL を設定します。詳細は、iSCSI ACL の作成 を参照してください。

関連情報

-

システム上の

targetcli(8)man ページ

6.10. 読み取り専用の iSCSI LUN の作成

デフォルトでは、読み書きパーミッションを持つ LUN が作成されます。読み取り専用の LUN を作成できます。

前提条件

-

targetcliをインストールして、実行している。詳細は、targetcli のインストール を参照してください。 - ターゲットポータルグループ (TPG) に関連付けられた iSCSI ターゲット。詳細は、iSCSI ターゲットの作成 を参照してください。

- 作成したストレージオブジェクト。詳細は、iSCSI バックストア を参照してください。

手順

読み取り専用パーミッションを設定します。

/> set global auto_add_mapped_luns=false Parameter auto_add_mapped_luns is now 'false'.これにより、LUN が既存の ACL へ自動的にマッピングされないようになり、LUN を手動でマッピングできるようになります。

initiator_iqn_name ディレクトリーに移動します。

/> iscsi/target_iqn_name/tpg1/acls/initiator_iqn_name/LUN を作成します。

/iscsi/target_iqn_name/tpg1/acls/initiator_iqn_name> create mapped_lun=next_sequential_LUN_number tpg_lun_or_backstore=backstore write_protect=1

たとえば、以下のようになります。

/iscsi/target_iqn_name/tpg1/acls/2006-04.com.example:888> create mapped_lun=1 tpg_lun_or_backstore=/backstores/block/block2 write_protect=1 Created LUN 1. Created Mapped LUN 1.作成した LUN を確認します。

/iscsi/target_iqn_name/tpg1/acls/2006-04.com.example:888> ls o- 2006-04.com.example:888 .. [Mapped LUNs: 2] | o- mapped_lun0 .............. [lun0 block/disk1 (rw)] | o- mapped_lun1 .............. [lun1 block/disk2 (ro)](mapped_lun0 の (

rw) とは異なり) mapped_lun1 行の最後に (ro) が表示されますが、これは、読み取り専用であることを表しています。- ACL を設定します。詳細は、iSCSI ACL の作成 を参照してください。

関連情報

-

システム上の

targetcli(8)man ページ

6.11. iSCSI ACL の作成

targetcli サービスは、アクセスコントロールリスト (ACL) を使用してアクセスルールを定義し、各イニシエーターに論理ユニット番号 (LUN) へのアクセスを許可します。

ターゲットとイニシエーターにはどちらも一意の識別名があります。ACL を設定するには、イニシエーターの一意の名前を知っている必要があります。iscsi-initiator-utils パッケージによって提供される /etc/iscsi/initiatorname.iscsi ファイルには、iSCSI イニシエーター名が含まれています。

前提条件

-

targetcliサービスが インストール され、実行されている。 - ターゲットポータルグループ (TPG) に関連付けられた iSCSI ターゲット。

手順

- オプション: ACL への LUN の自動マッピングを無効にするには、読み取り専用の iSCSI LUN の作成 を参照してください。

acls ディレクトリーへ移動します。

/> iscsi/target_iqn_name/tpg_name/acls/ACL を作成するには、以下のいずれかのオプションを使用します。

イニシエーターの

/etc/iscsi/initiatorname.iscsiファイルの initiator_iqn_name を使用します。iscsi/target_iqn_name/tpg_name/acls> create initiator_iqn_name Created Node ACL for initiator_iqn_name Created mapped LUN 2. Created mapped LUN 1. Created mapped LUN 0.

Custom_name を使用し、それに一致するようにイニシエーターを更新します。

iscsi/target_iqn_name/tpg_name/acls> create custom_name Created Node ACL for custom_name Created mapped LUN 2. Created mapped LUN 1. Created mapped LUN 0.

イニシエーター名の更新については、iSCSI イニシエーターの作成 を参照してください。

検証

作成した ACL を確認します。

iscsi/target_iqn_name/tpg_name/acls> ls o- acls .................................................[1 ACL] o- target_iqn_name ....[3 Mapped LUNs, auth] o- mapped_lun0 .............[lun0 ramdisk/ramdisk1 (rw)] o- mapped_lun1 .................[lun1 block/block1 (rw)] o- mapped_lun2 .................[lun2 fileio/file1 (rw)]

関連情報

-

システム上の

targetcli(8)man ページ

6.12. ターゲットのチャレンジハンドシェイク認証プロトコルの設定

Challenge-Handshake Authentication Protocol (CHAP) を使用すると、パスワードでターゲットを保護できます。イニシエーターは、このパスワードでターゲットに接続できることを認識している必要があります。

前提条件

- iSCSI ACL を作成している。詳細は、iSCSI ACL の作成 を参照してください。

手順

属性認証を設定します。

/iscsi/iqn.20...mple:444/tpg1> set attribute authentication=1 Parameter authentication is now '1'.useridとpasswordを設定します。/tpg1> set auth userid=redhat Parameter userid is now 'redhat'. /iscsi/iqn.20...689dcbb3/tpg1> set auth password=redhat_passwd Parameter password is now 'redhat_passwd'.

関連情報

-

システム上の

targetcli(8)man ページ

6.13. targetcli ツールで iSCSI オブジェクトの削除

targetcli ツールを使用して iSCSI オブジェクトを削除できます。

手順

ターゲットからログオフします。

# iscsiadm -m node -T iqn.2006-04.example:444 -uターゲットへのログイン方法は、iSCSI イニシエーターの作成 を参照してください。

ACL、LUN、およびポータルのすべてを含め、ターゲット全体を削除します。

/> iscsi/ delete iqn.2006-04.com.example:444iqn.2006-04.com.example:444 を target_iqn_name に置き換えます。

iSCSI バックストアを削除するには、次のコマンドを実行します。

/> backstores/backstore-type/ delete block_backend-

backstore-type を

fileio、block、pscsi、またはramdiskに置き換えます。 - block_backend を、削除する バックストア名 に置き換えます。

-

backstore-type を

ACL などの iSCSI ターゲットの一部を削除するには、次のコマンドを実行します。

/> /iscsi/iqn-name/tpg/acls/ delete iqn.2006-04.com.example:444

検証

変更を表示します。

/> iscsi/ ls

関連情報

-

システム上の

targetcli(8)man ページ

第7章 iSCSI イニシエーターの設定

iSCSI イニシエーターは iSCSI ターゲットに接続するセッションを形成します。デフォルトでは、iSCSI サービスは起動に時間がかかり、iscsiadm コマンドの実行後にサービスが起動します。root が iSCSI デバイスにない場合や、node.startup = automatic でマークされたノードがない場合は、iscsiadm コマンドが実行するまで iSCSI サービスが起動しなくなります。これには、カーネルモジュール iscsid または iscsi の起動が必要になります。

root で systemctl start iscsid.service コマンドを実行し、iscsid デーモンを強制的に実行して、iSCSI カーネルモジュールを読み込みます。

7.1. iSCSI イニシエーターの作成

サーバー上のストレージデバイスにアクセスするために、iSCSI ターゲットに接続するための iSCSI イニシエーターを作成します。

前提条件

iSCSI ターゲットのホスト名と IP アドレスがあります。

- 外部ソフトウェアが作成したストレージターゲットに接続している場合は、ストレージ管理者からターゲットのホスト名と IP アドレスを取得します。

- iSCSI ターゲットを作成する場合は、iSCSI ターゲットの作成 を参照してください。

手順

クライアントマシンに

iscsi-initiator-utilsをインストールします。# dnf install iscsi-initiator-utilsイニシエーター名を確認します。

# cat /etc/iscsi/initiatorname.iscsi InitiatorName=iqn.2006-04.com.example:888iSCSI ACL の作成 で ACL にカスタム名を指定した場合は、ACL と一致するようにイニシエーター名を更新します。

/etc/iscsi/initiatorname.iscsiファイルを開き、イニシエーター名を変更します。# vi /etc/iscsi/initiatorname.iscsi InitiatorName=custom-name

iscsidサービスを再起動します。# systemctl restart iscsid

ターゲットを検出し、表示されたターゲット IQN でターゲットにログインします。

# iscsiadm -m discovery -t st -p 10.64.24.179 10.64.24.179:3260,1 iqn.2006-04.example:444 # iscsiadm -m node -T iqn.2006-04.example:444 -l Logging in to [iface: default, target: iqn.2006-04.example:444, portal: 10.64.24.179,3260] (multiple) Login to [iface: default, target: iqn.2006-04.example:444, portal: 10.64.24.179,3260] successful.

10.64.24.179 を、target-ip-address に置き換えます。

この手順では、iSCSI ACL の作成 で説明されているように、それぞれのイニシエーター名が ACL に追加されている場合は、同じターゲットに接続されている任意の数のイニシエーターに対してこの手順を使用できます。

iSCSI ディスク名を確認して、この iSCSI ディスクにファイルシステムを作成します。

# grep "Attached SCSI" /var/log/messages # mkfs.ext4 /dev/disk_name

disk_name を、

/var/log/messagesファイルに記載されている iSCSI ディスク名に置き換えます。ファイルシステムをマウントします。

# mkdir /mount/point # mount /dev/disk_name /mount/point

/mount/point を、パーティションのマウントポイントに置き換えます。

システムの起動時にファイルシステムを自動的にマウントするように

/etc/fstabを編集します。# vi /etc/fstab /dev/disk_name /mount/point ext4 _netdev 0 0

disk_name を iSCSI ディスク名に置き換え、/mount/point を、パーティションのマウントポイントに置き換えます。

関連情報

-

システム上の

targetcli(8)およびiscsiadm(8)man ページ

7.2. イニシエーター用のチャレンジハンドシェイク認証プロトコルの設定

Challenge-Handshake Authentication Protocol (CHAP) を使用すると、パスワードでターゲットを保護できます。イニシエーターは、このパスワードでターゲットに接続できることを認識している必要があります。

前提条件

- iSCSI イニシエーターを作成しました。詳細は、iSCSI イニシエーターの作成 を参照してください。

-

ターゲットの

CHAPを設定します。詳細は、ターゲットのチャレンジハンドシェイク認証プロトコルの設定 を参照してください。

手順

iscsid.confファイルで CHAP 認証を有効にします。# vi /etc/iscsi/iscsid.conf node.session.auth.authmethod = CHAPデフォルトでは、

node.session.auth.authmethodはNoneに設定されています。ターゲットの

usernameとpasswordをiscsid.confファイルに追加します。node.session.auth.username = redhat node.session.auth.password = redhat_passwd

iscsidデーモンを起動します。# systemctl start iscsid.service

関連情報

-

システム上の

iscsiadm(8)man ページ

7.3. iscsiadm ユーティリティーで iSCSI セッションの監視

iscsiadm ユーティリティーを使用して iSCSI セッションを監視できます。

デフォルトでは、iSCSI サービスの起動は lazily で、iscsiadm コマンドの実行後にサービスが起動します。root が iSCSI デバイスにない場合や、node.startup = automatic でマークされたノードがない場合は、iscsiadm コマンドが実行するまで iSCSI サービスが起動しなくなります。これには、カーネルモジュール iscsid または iscsi の起動が必要になります。

iscsid デーモンを強制的に実行し、iSCSI カーネルモジュールをロードするには、root として systemctl start iscsid.service コマンドを使用します。

手順

クライアントマシンに

iscsi-initiator-utilsをインストールします。# dnf install iscsi-initiator-utils実行中のセッションに関する情報を検索します。

# iscsiadm -m session -P 3このコマンドは、セッションまたはデバイスの状態、セッション ID (sid)、いくつかのネゴシエートしたパラメーター、およびセッション経由でアクセス可能な SCSI デバイスを表示します。

より短い出力 (たとえば

sid-to-node間のマッピングのみの表示) には、次のコマンドを実行します。# iscsiadm -m session -P 0 or # iscsiadm -m session tcp [2] 10.15.84.19:3260,2 iqn.1992-08.com.netapp:sn.33615311 tcp [3] 10.15.85.19:3260,3 iqn.1992-08.com.netapp:sn.33615311

このコマンドは、

driver [sid] target_ip:port,target_portal_group_tag proper_target_nameの形式で実行中のセッションのリストを表示します。

関連情報

-

/usr/share/doc/iscsi-initiator-utils-version/READMEファイル -

システム上の

iscsiadm(8)man ページ

7.4. DM Multipath がデバイスタイムアウトの上書き

recovery_tmo sysfs オプションは、特定の iSCSI デバイスのタイムアウトを制御します。次のオプションは、システム全体の recovery_tmo 値を上書きします。

-

replacement_timeout設定オプションは、システム全体で全 iSCSI デバイスのrecovery_tmo値を上書きします。 DM Multipath が管理するすべての iSCSI デバイスで、DM Multipath の

fast_io_fail_tmoオプションは、システム全体のrecovery_tmo値を上書きします。DM Multipath の

fast_io_fail_tmoオプションは、ファイバーチャネルデバイスのfast_io_fail_tmoオプションを上書きします。

DM Multipath の fast_io_fail_tmo オプションは replacement_timeout よりも優先します。Red Hat では、replacement_timeou を使用して、DM Multipath が管理するデバイスの recovery_tmo を上書きすることは推奨しません。これは、multipathd サービスが再読み込みを行うと、DM Multipath が常に recovery_tmo をリセットするためです。

第8章 ファイバーチャネルデバイスの使用

Red Hat Enterprise Linux 9 は、以下のネイティブファイバーチャネルドライバーを提供します。

-

lpfc -

qla2xxx -

zfcp

8.1. ファイバーチャネル論理ユニットのサイズ変更

システム管理者は、ファイバーチャネルの論理ユニットのサイズを変更できます。

手順

multipath論理ユニットのパスとなるデバイスを特定します。# multipath -llマルチパスを使用するシステムで、ファイバーチャネル論理ユニットを再スキャンします。

$ echo 1 > /sys/block/sdX/device/rescan

関連情報

-

システム上の

multipath(8)man ページ

8.2. ファイバーチャネルでデバイスのリンク切れ動作の特定

ドライバーがトランスポートの dev_loss_tmo コールバックを実装している場合、トランスポートの問題が検出されるとリンクを経由したデバイスへのアクセス試行がブロックされます。

手順

リモートポートの状態を判断します。

$ cat /sys/class/fc_remote_ports/rport-host:bus:remote-port/port_stateこのコマンドは、次のいずれかの出力を返します。

-

リモートポートからアクセスしたデバイスとともにリモートポートがブロックされると

Blockedとなります。 リモートポートが正常に動作しているときには

Onlineとなりますdev_loss_tmo秒以内に問題が解決されない場合は、rportおよびデバイスのブロックが解除されます。そのデバイスで実行しているすべての I/O は、そのデバイスに送信された新しい I/O とともにすべて失敗します。

-

リモートポートからアクセスしたデバイスとともにリモートポートがブロックされると

リンクロスが dev_loss_tmo を超えると、scsi_device デバイスおよび sd_N_ デバイスが削除されます。通常、ファイバーチャネルクラスはデバイスをそのままにします。つまり、/dev/sdx は、/dev/sdx のままになります。これは、ターゲットバインディングがファイバーチャネルドライバーによって保存され、ターゲットポートが戻されると、SCSI アドレスは同様に再作成されます。ただし、これは保証されません。LUN のストレージ内ボックス設定に追加の変更がない場合に限り、sdx デバイスが復元されます。

関連情報

-

システム上の

multipath.conf(5)man ページ - Recommended tuning at scsi,multipath and at application layer while configuring Oracle RAC cluster (Red Hat ナレッジベース)

8.3. ファイバーチャネル設定ファイル

以下は、ユーザー空間の API をファイバーチャネルに提供する /sys/class/ ディレクトリーの設定ファイルのリストです。

項目は以下の変数を使用します。

H- ホスト番号

B- バス番号

T- ターゲット

L- 論理ユニット (LUN)

-R- リモートポート番号

システムでマルチパスソフトウェアを使用している場合は、本セクションで説明されている値を変更する前にハードウェアベンダーにお問い合わせください。

/sys/class/fc_transport/targetH:B:T/ のトランスポート設定

port_id- 24 ビットのポート ID/アドレス

node_name- 64 ビットのノード名

port_name- 64 ビットのポート名

/sys/class/fc_remote_ports/rport-H:B-R/ のリモートポート設定

-

port_id -

node_name -

port_name dev_loss_tmoscsi デバイスがシステムから削除されるタイミングを制御します。

dev_loss_tmoがトリガーされると、scsi デバイスが削除されます。multipath.confファイルでは、dev_loss_tmoをinfinityに設定できます。Red Hat Enterprise Linux 9 では、

fast_io_fail_tmoオプションを設定しないと、dev_loss_tmoは600秒に制限されます。デフォルトでは、multipathdサービスが実行している場合は、Red Hat Enterprise Linux 9 でfast_io_fail_tmoが5秒に設定されています。それ以外の場合はoffに設定されます。fast_io_fail_tmoリンクに "bad" のマークが付くまでの待機秒数を指定します。リンクに bad のマークが付けられると、対応するパス上の既存の実行中の I/O または新しい I/O が失敗します。

I/O がブロックされたキューに存在する場合は、

dev_loss_tmoの期限が切れ、キューのブロックが解除されるまでエラーを起こしません。fast_io_fail_tmoを off 以外の値に設定すると、dev_loss_tmoは取得されません。fast_io_fail_tmoを off に設定すると、システムからデバイスが削除されるまで I/O は失敗します。fast_io_fail_tmoに数値を設定すると、fast_io_fail_tmoタイムアウトが発生するとすぐに I/O が失敗します。

/sys/class/fc_host/hostH/ のホスト設定

-

port_id -

node_name -

port_name issue_lipリモートポートを再検出するようにドライバーに指示します。

8.4. DM Multipath がデバイスタイムアウトの上書き

recovery_tmo sysfs オプションは、特定の iSCSI デバイスのタイムアウトを制御します。次のオプションは、システム全体の recovery_tmo 値を上書きします。

-

replacement_timeout設定オプションは、システム全体で全 iSCSI デバイスのrecovery_tmo値を上書きします。 DM Multipath が管理するすべての iSCSI デバイスで、DM Multipath の

fast_io_fail_tmoオプションは、システム全体のrecovery_tmo値を上書きします。DM Multipath の

fast_io_fail_tmoオプションは、ファイバーチャネルデバイスのfast_io_fail_tmoオプションを上書きします。

DM Multipath の fast_io_fail_tmo オプションは replacement_timeout よりも優先します。Red Hat では、replacement_timeou を使用して、DM Multipath が管理するデバイスの recovery_tmo を上書きすることは推奨しません。これは、multipathd サービスが再読み込みを行うと、DM Multipath が常に recovery_tmo をリセットするためです。

第9章 NVMe over fabric デバイスの概要

Non-volatile Memory Express™ (NVMe™) は、ホストソフトウェアユーティリティーがソリッドステートドライブと通信できるようにするインターフェイスです。

次の種類のファブリックトランスポートを使用して、NVMe over fabric デバイスを設定します。

- NVMe over Remote Direct Memory Access (NVMe/RDMA)

- NVMe™/RDMA の設定方法については、NVMe/RDMA を使用した NVMe over Fabric の設定 を参照してください。

- NVMe over Fibre Channel (NVMe/FC)

- NVMe™/FC の設定方法については、NVMe/FC を使用した NVMe over Fabric の設定 を参照してください。

- NVMe over TCP (NVMe/TCP)

- NVMe/FC の設定方法については、Configuring NVMe over fabrics using NVMe/TCP を参照してください。

ファブリック上で NVMe を使用する場合、ソリッドステートドライブはシステムに対してローカルである必要はありません。NVMe over Fabrics デバイスを介してリモートで設定できます。

第10章 NVMe/RDMA を使用した NVMe over Fabric の設定

Non-volatile Memory Express™ (NVMe™) over RDMA (NVMe™/RDMA) 設定では、NVMe コントローラーと NVMe イニシエーターを設定します。

10.1. configfs を使用した NVMe/RDMA コントローラーのセットアップ

configfs を使用して、Non-volatile Memory Express™ (NVMe™) over RDMA (NVMe™/RDMA) コントローラーを設定できます。

前提条件

-

nvmetサブシステムに割り当てるブロックデバイスがあることを確認する。

手順

nvmet-rdmaサブシステムを作成します。# modprobe nvmet-rdma # mkdir /sys/kernel/config/nvmet/subsystems/testnqn # cd /sys/kernel/config/nvmet/subsystems/testnqn

testnqn を、サブシステム名に置き換えます。

すべてのホストがこのコントローラーに接続できるようにします。

# echo 1 > attr_allow_any_hostnamespace を設定します。

# mkdir namespaces/10 # cd namespaces/10

10 を、namespace の数値に置き換えます。

NVMe デバイスへのパスを設定します。

# echo -n /dev/nvme0n1 > device_pathnamespace を有効にします。

# echo 1 > enableNVMe ポートでディレクトリーを作成します。

# mkdir /sys/kernel/config/nvmet/ports/1 # cd /sys/kernel/config/nvmet/ports/1

mlx5_ib0 の IP アドレスを表示します。

# ip addr show mlx5_ib0 8: mlx5_ib0: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 4092 qdisc mq state UP group default qlen 256 link/infiniband 00:00:06:2f:fe:80:00:00:00:00:00:00:e4:1d:2d:03:00:e7:0f:f6 brd 00:ff:ff:ff:ff:12:40:1b:ff:ff:00:00:00:00:00:00:ff:ff:ff:ff inet 172.31.0.202/24 brd 172.31.0.255 scope global noprefixroute mlx5_ib0 valid_lft forever preferred_lft forever inet6 fe80::e61d:2d03:e7:ff6/64 scope link noprefixroute valid_lft forever preferred_lft foreverコントローラーのトランスポートアドレスを設定します。

# echo -n 172.31.0.202 > addr_traddrRDMA をトランスポートタイプとして設定します。

# echo rdma > addr_trtype # echo 4420 > addr_trsvcid

ポートのアドレスファミリーを設定します。

# echo ipv4 > addr_adrfamソフトリンクを作成します。

# ln -s /sys/kernel/config/nvmet/subsystems/testnqn /sys/kernel/config/nvmet/ports/1/subsystems/testnqn

検証

NVMe コントローラーが指定されたポートでリッスンしていて、接続要求の準備ができていることを確認します。

# dmesg | grep "enabling port" [ 1091.413648] nvmet_rdma: enabling port 1 (172.31.0.202:4420)

関連情報

-

システム上の

nvme(1)man ページ

10.2. nvmetcli を使用した NVMe/RDMA コントローラーのセットアップ

nvmetcli ユーティリティーを使用して、Non-volatile Memory Express™ (NVMe™) over RDMA (NVMe™/RDMA) コントローラーを設定できます。nvmetcli ユーティリティーには、コマンドラインと対話式のシェルオプションが用意されています。

前提条件

-

nvmetサブシステムに割り当てるブロックデバイスがあることを確認する。 -

root で、以下の

nvmetcli操作を実行する。

手順

nvmetcliパッケージをインストールします。# dnf install nvmetclirdma.jsonファイルをダウンロードします。# wget http://git.infradead.org/users/hch/nvmetcli.git/blob_plain/0a6b088db2dc2e5de11e6f23f1e890e4b54fee64:/rdma.json-

rdma.jsonファイルを編集して、traddrの値を172.31.0.202に変更します。 NVMe コントローラー設定ファイルをロードして、コントローラーをセットアップします。

# nvmetcli restore rdma.json

NVMe コントローラー設定ファイル名を指定しない場合は、nvmetcli が /etc/nvmet/config.json ファイルを使用します。

検証

NVMe コントローラーが指定されたポートでリッスンしていて、接続要求の準備ができていることを確認します。

# dmesg | tail -1 [ 4797.132647] nvmet_rdma: enabling port 2 (172.31.0.202:4420)オプション: 現在の NVMe コントローラーをクリアします。

# nvmetcli clear

関連情報

-

システム上の

nvmetcliおよびnvme(1)man ページ

10.3. NVMe/RDMA ホストの設定

NVMe 管理コマンドラインインターフェイス (nvme-cli) ツールを使用して、Non-volatile Memory Express™ (NVMe™) over RDMA (NVMe™/RDMA) ホストを設定できます。

手順

nvme-cliツールをインストールします。# dnf install nvme-clinvme-rdmaモジュールが読み込まれていない場合は、読み込みます。# modprobe nvme-rdmaNVMe コントローラーで使用可能なサブシステムを検出します。

# nvme discover -t rdma -a 172.31.0.202 -s 4420 Discovery Log Number of Records 1, Generation counter 2 =====Discovery Log Entry 0====== trtype: rdma adrfam: ipv4 subtype: nvme subsystem treq: not specified, sq flow control disable supported portid: 1 trsvcid: 4420 subnqn: testnqn traddr: 172.31.0.202 rdma_prtype: not specified rdma_qptype: connected rdma_cms: rdma-cm rdma_pkey: 0x0000

検出されたサブシステムに接続します。

# nvme connect -t rdma -n testnqn -a 172.31.0.202 -s 4420 # lsblk NAME MAJ:MIN RM SIZE RO TYPE MOUNTPOINT sda 8:0 0 465.8G 0 disk ├─sda1 8:1 0 1G 0 part /boot └─sda2 8:2 0 464.8G 0 part ├─rhel_rdma--virt--03-root 253:0 0 50G 0 lvm / ├─rhel_rdma--virt--03-swap 253:1 0 4G 0 lvm [SWAP] └─rhel_rdma--virt--03-home 253:2 0 410.8G 0 lvm /home nvme0n1 # cat /sys/class/nvme/nvme0/transport rdma

testnqn を NVMe サブシステム名に置き換えます。

172.31.0.202 をコントローラーの IP アドレスに置き換えます。

4420 を、ポート番号に置き換えます。

検証

現在接続されている NVMe デバイスのリストを表示します。

# nvme listオプション: コントローラーから切断します。

# nvme disconnect -n testnqn NQN:testnqn disconnected 1 controller(s) # lsblk NAME MAJ:MIN RM SIZE RO TYPE MOUNTPOINT sda 8:0 0 465.8G 0 disk ├─sda1 8:1 0 1G 0 part /boot └─sda2 8:2 0 464.8G 0 part ├─rhel_rdma--virt--03-root 253:0 0 50G 0 lvm / ├─rhel_rdma--virt--03-swap 253:1 0 4G 0 lvm [SWAP] └─rhel_rdma--virt--03-home 253:2 0 410.8G 0 lvm /home

関連情報

-

システム上の

nvme(1)man ページ

10.4. 次のステップ

第11章 NVMe/FC を使用した NVMe over Fabric の設定

Non-volatile Memory Express™ (NVMe™) over Fibre Channel (NVMe™/FC) トランスポートは、特定の Broadcom Emulex および Marvell Qlogic ファイバーチャネルアダプターと共に使用する場合、ホストモードで完全にサポートされます。

11.1. Broadcom アダプターの NVMe ホストの設定

NVMe 管理コマンドラインインターフェイス (nvme-cli) ユーティリティーを使用して、Broadcom アダプタークライアントの Non-volatile Memory Express™ (NVMe™) ホストを設定できます。

手順

nvme-cliユーティリティーをインストールします。# dnf install nvme-cliこれにより、

/etc/nvme/ディレクトリーにhostnqnファイルが作成されます。hostnqnファイルは、NVMe ホストを識別します。ローカルポートとリモートポートのワールドワイドノード名 (WWNN) とワールドワイドポート名 (WWPN) 識別子を見つけます。

# cat /sys/class/scsi_host/host*/nvme_info NVME Host Enabled XRI Dist lpfc0 Total 6144 IO 5894 ELS 250 NVME LPORT lpfc0 WWPN x10000090fae0b5f5 WWNN x20000090fae0b5f5 DID x010f00 ONLINE NVME RPORT WWPN x204700a098cbcac6 WWNN x204600a098cbcac6 DID x01050e TARGET DISCSRVC ONLINE NVME Statistics LS: Xmt 000000000e Cmpl 000000000e Abort 00000000 LS XMIT: Err 00000000 CMPL: xb 00000000 Err 00000000 Total FCP Cmpl 00000000000008ea Issue 00000000000008ec OutIO 0000000000000002 abort 00000000 noxri 00000000 nondlp 00000000 qdepth 00000000 wqerr 00000000 err 00000000 FCP CMPL: xb 00000000 Err 00000000これらの

host-traddrとtraddrの値を使用して、サブシステムの NVMe 修飾名 (NQN) を検索します。# nvme discover --transport fc \ --traddr nn-0x204600a098cbcac6:pn-0x204700a098cbcac6 \ --host-traddr nn-0x20000090fae0b5f5:pn-0x10000090fae0b5f5 Discovery Log Number of Records 2, Generation counter 49530 =====Discovery Log Entry 0====== trtype: fc adrfam: fibre-channel subtype: nvme subsystem treq: not specified portid: 0 trsvcid: none subnqn: nqn.1992-08.com.netapp:sn.e18bfca87d5e11e98c0800a098cbcac6:subsystem.st14_nvme_ss_1_1 traddr: nn-0x204600a098cbcac6:pn-0x204700a098cbcac6nn-0x204600a098cbcac6:pn-0x204700a098cbcac6 を、

traddrに置き換えます。nn-0x20000090fae0b5f5:pn-0x10000090fae0b5f5 を、

host-traddrに置き換えます。nvme-cliを使用して NVMe コントローラーに接続します。# nvme connect --transport fc \ --traddr nn-0x204600a098cbcac6:pn-0x204700a098cbcac6 \ --host-traddr nn-0x20000090fae0b5f5:pn-0x10000090fae0b5f5 \ -n nqn.1992-08.com.netapp:sn.e18bfca87d5e11e98c0800a098cbcac6:subsystem.st14_nvme_ss_1_1 \ -k 5注記接続時間がデフォルトの keep-alive タイムアウト値を超えると

keep-alive timer (5 seconds) expired!と表示される場合は、-kオプションを使用して値を増やします。たとえば、-k 7を使用できます。ここでは、以下のようになります。

nn-0x204600a098cbcac6:pn-0x204700a098cbcac6 を、

traddrに置き換えます。nn-0x20000090fae0b5f5:pn-0x10000090fae0b5f5 を、

host-traddrに置き換えます。nqn.1992-08.com.netapp:sn.e18bfca87d5e11e98c0800a098cbcac6:subsystem.st14_nvme_ss_1_1 を、

subnqnに置き換えます。5 を keep-alive タイムアウト値 (秒単位) に置き換えます。

検証

現在接続されている NVMe デバイスのリストを表示します。

# nvme list Node SN Model Namespace Usage Format FW Rev ---------------- -------------------- ---------------------------------------- --------- -------------------------- ---------------- -------- /dev/nvme0n1 80BgLFM7xMJbAAAAAAAC NetApp ONTAP Controller 1 107.37 GB / 107.37 GB 4 KiB + 0 B FFFFFFFF # lsblk |grep nvme nvme0n1 259:0 0 100G 0 disk

関連情報

-

システム上の

nvme(1)man ページ

11.2. QLogic アダプターの NVMe ホストの設定

NVMe 管理コマンドラインインターフェイス (nvme-cli) ユーティリティーを使用して、Qlogic アダプタークライアントの Non-volatile Memory Express™ (NVMe™) ホストを設定できます。

手順

nvme-cliユーティリティーをインストールします。# dnf install nvme-cliこれにより、

/etc/nvme/ディレクトリーにhostnqnファイルが作成されます。hostnqnファイルは、NVMe ホストを識別します。qla2xxxを再読み込みします。# modprobe -r qla2xxx # modprobe qla2xxx

ローカルポートとリモートポートのワールドワイドノード名 (WWNN) とワールドワイドポート名 (WWPN) 識別子を見つけます。

# dmesg |grep traddr [ 6.139862] qla2xxx [0000:04:00.0]-ffff:0: register_localport: host-traddr=nn-0x20000024ff19bb62:pn-0x21000024ff19bb62 on portID:10700 [ 6.241762] qla2xxx [0000:04:00.0]-2102:0: qla_nvme_register_remote: traddr=nn-0x203b00a098cbcac6:pn-0x203d00a098cbcac6 PortID:01050dこれらの

host-traddrとtraddrの値を使用して、サブシステムの NVMe 修飾名 (NQN) を検索します。# nvme discover --transport fc \ --traddr nn-0x203b00a098cbcac6:pn-0x203d00a098cbcac6 \ --host-traddr nn-0x20000024ff19bb62:pn-0x21000024ff19bb62 Discovery Log Number of Records 2, Generation counter 49530 =====Discovery Log Entry 0====== trtype: fc adrfam: fibre-channel subtype: nvme subsystem treq: not specified portid: 0 trsvcid: none subnqn: nqn.1992-08.com.netapp:sn.c9ecc9187b1111e98c0800a098cbcac6:subsystem.vs_nvme_multipath_1_subsystem_468 traddr: nn-0x203b00a098cbcac6:pn-0x203d00a098cbcac6nn-0x203b00a098cbcac6:pn-0x203d00a098cbcac6 を、

traddrに置き換えます。nn-0x20000024ff19bb62:pn-0x21000024ff19bb62 を、

host-traddrに置き換えます。nvme-cliツールを使用して NVMe コントローラーに接続します。# nvme connect --transport fc \ --traddr nn-0x203b00a098cbcac6:pn-0x203d00a098cbcac6 \ --host-traddr nn-0x20000024ff19bb62:pn-0x21000024ff19bb62 \ -n nqn.1992-08.com.netapp:sn.c9ecc9187b1111e98c0800a098cbcac6:subsystem.vs_nvme_multipath_1_subsystem_468\ -k 5注記接続時間がデフォルトの keep-alive タイムアウト値を超えると

keep-alive timer (5 seconds) expired!と表示される場合は、-kオプションを使用して値を増やします。たとえば、-k 7を使用できます。ここでは、以下のようになります。

nn-0x203b00a098cbcac6:pn-0x203d00a098cbcac6 を、

traddrに置き換えます。nn-0x20000024ff19bb62:pn-0x21000024ff19bb62 を、

host-traddrに置き換えます。nqn.1992-08.com.netapp:sn.c9ecc9187b1111e98c0800a098cbcac6:subsystem.vs_nvme_multipath_1_subsystem_468 を、

subnqnに置き換えます。5 を keep-live タイムアウト値 (秒単位) に置き換えます。

検証

現在接続されている NVMe デバイスのリストを表示します。

# nvme list Node SN Model Namespace Usage Format FW Rev ---------------- -------------------- ---------------------------------------- --------- -------------------------- ---------------- -------- /dev/nvme0n1 80BgLFM7xMJbAAAAAAAC NetApp ONTAP Controller 1 107.37 GB / 107.37 GB 4 KiB + 0 B FFFFFFFF # lsblk |grep nvme nvme0n1 259:0 0 100G 0 disk

関連情報

-

システム上の

nvme(1)man ページ

11.3. 次のステップ

第12章 NVMe/TCP を使用した NVMe over Fabrics の設定

Non-volatile Memory Express™ (NVMe™) over TCP (NVMe/TCP) 設定では、ホストモードは完全にサポートされており、コントローラーセットアップはサポートされていません。

RHEL 9 では、ネイティブ NVMe マルチパスがデフォルトで有効になっています。DM マルチパスの有効化は、NVMe/TCP ではサポートされていません。

12.1. NVMe/TCP ホストの設定

NVMe 管理コマンドラインインターフェイス (nvme-cli) ツールを使用して、Non-volatile Memory Express™ (NVMe™) over TCP (NVMe/TCP) ホストを設定できます。

手順

nvme-cliツールをインストールします。# dnf install nvme-cliこのツールは、NVMe ホストを識別する

hostnqnファイルを/etc/nvme/ディレクトリーに作成します。nvme

hostidとhostnqnを見つけます。# cat /etc/nvme/hostnqn nqn.2014-08.org.nvmexpress:uuid:8ae2b12c-3d28-4458-83e3-658e571ed4b8 # cat /etc/nvme/hostid 09e2ce17-ccc9-412d-8dcf-2b0a1d581ee3

hostid値およびhostnqnの値を使用して、NVMe/TCP コントローラーを設定します。コントローラーのステータスを確認します。

# nmcli device show ens6 GENERAL.DEVICE: ens6 GENERAL.TYPE: ethernet GENERAL.HWADDR: 52:57:02:12:02:02 GENERAL.MTU: 1500 GENERAL.STATE: 30 (disconnected) GENERAL.CONNECTION: -- GENERAL.CON-PATH: -- WIRED-PROPERTIES.CARRIER: on

静的 IP アドレスを使用して、新しくインストールされたイーサネットコントローラーのホストネットワークを設定します。

# nmcli connection add con-name ens6 ifname ens6 type ethernet ip4 192.168.101.154/24 gw4 192.168.101.1ここで、192.168.101.154 をホスト IP アドレスに置き換えます。

# nmcli connection mod ens6 ipv4.method manual # nmcli connection up ens6

NVMe/TCP ホストを NVMe/TCP コントローラーに接続するための新しいネットワークが作成されるため、コントローラーでもこの手順を実行します。

検証

新しく作成されたホストネットワークが正しく機能するかどうかを確認します。

# nmcli device show ens6 GENERAL.DEVICE: ens6 GENERAL.TYPE: ethernet GENERAL.HWADDR: 52:57:02:12:02:02 GENERAL.MTU: 1500 GENERAL.STATE: 100 (connected) GENERAL.CONNECTION: ens6 GENERAL.CON-PATH: /org/freedesktop/NetworkManager/ActiveConnection/5 WIRED-PROPERTIES.CARRIER: on IP4.ADDRESS[1]: 192.168.101.154/24 IP4.GATEWAY: 192.168.101.1 IP4.ROUTE[1]: dst = 192.168.101.0/24, nh = 0.0.0.0, mt = 101 IP4.ROUTE[2]: dst = 192.168.1.1/32, nh = 0.0.0.0, mt = 101 IP4.ROUTE[3]: dst = 0.0.0.0/0, nh = 192.168.1.1, mt = 101 IP6.ADDRESS[1]: fe80::27ce:dde1:620:996c/64 IP6.GATEWAY: -- IP6.ROUTE[1]: dst = fe80::/64, nh = ::, mt = 101

関連情報

-

システム上の

nvme(1)man ページ

12.2. NVMe/TCP ホストを NVMe/TCP コントローラーに接続する

NVMe™ over TCP (NVMe/TCP) ホストを NVMe/TCP コントローラーシステムに接続して、NVMe/TCP ホストが名前空間にアクセスできるようになったことを確認します。

NVMe/TCP コントローラー (nvmet-tcp) モジュールはサポートされていません。

前提条件

- NVMe/TCP ホストを設定しました。詳細は NVMe/TCP ホストの設定 を参照してください。

- 外部ストレージソフトウェアを使用して NVMe/TCP コントローラーを設定し、コントローラーでネットワークを設定しました。この手順では、192.168.101.55 が NVMe/TCP コントローラーの IP アドレスです。

手順

nvme_tcpモジュールをロードしていない場合はロードします。# modprobe nvme-tcpNVMe コントローラーで使用可能なサブシステムを検出します。

# nvme discover --transport=tcp --traddr=192.168.101.55 --host-traddr=192.168.101.154 --trsvcid=8009 Discovery Log Number of Records 2, Generation counter 7 =====Discovery Log Entry 0====== trtype: tcp adrfam: ipv4 subtype: current discovery subsystem treq: not specified, sq flow control disable supported portid: 2 trsvcid: 8009 subnqn: nqn.2014-08.org.nvmexpress.discovery traddr: 192.168.101.55 eflags: not specified sectype: none =====Discovery Log Entry 1====== trtype: tcp adrfam: ipv4 subtype: nvme subsystem treq: not specified, sq flow control disable supported portid: 2 trsvcid: 8009 subnqn: nqn.2014-08.org.nvmexpress:uuid:0c468c4d-a385-47e0-8299-6e95051277db traddr: 192.168.101.55 eflags: not specified sectype: noneここで、192.168.101.55 は NVMe/TCP コントローラーの IP アドレスで、192.168.101.154 は NVMe/TCP ホストの IP アドレスです。

/etc/nvme/discovery.confファイルを設定して、nvme discoverコマンドで使用されるパラメーターを追加します。# echo "--transport=tcp --traddr=192.168.101.55 --host-traddr=192.168.101.154 --trsvcid=8009" >> /etc/nvme/discovery.confNVMe/TCP ホストをコントローラーシステムに接続します。

# nvme connect-all

検証

NVMe/TCP ホストが名前空間にアクセスできることを確認します。

# nvme list-subsys nvme-subsys3 - NQN=nqn.2014-08.org.nvmexpress:uuid:0c468c4d-a385-47e0-8299-6e95051277db \ +- nvme3 tcp traddr=192.168.101.55,trsvcid=8009,host_traddr=192.168.101.154 live optimized # nvme list Node Generic SN Model Namespace Usage Format FW Rev --------------------- --------------------- -------------------- ---------------------------------------- --------- -------------------------- ---------------- -------- /dev/nvme3n1 /dev/ng3n1 d93a63d394d043ab4b74 Linux 1 21.47 GB / 21.47 GB 512 B + 0 B 5.18.5-2

関連情報

-

システム上の

nvme(1)man ページ

第13章 NVMe デバイスでのマルチパスの有効化

ファイバーチャネル (FC) などのファブリックトランスポートを介して、システムに接続されている Non-volatile Memory Express™ (NVMe™) デバイスをマルチパスすることができます。複数のマルチパスソリューションを選択することができます。

13.1. ネイティブ NVMe マルチパスと DM Multipath

Non-volatile Memory Express™ (NVMe™) デバイスは、ネイティブなマルチパス機能をサポートしています。NVMe にマルチパスを設定する場合、標準の DM Multipath フレームワークと NVMe のネイティブなマルチパスのどちらかを選択できます。

DM Multipath と NVMe のネイティブマルチパスは、どちらも NVMe デバイスのマルチパス方式である ANA(Asymmetric Namespace Access) に対応しています。ANA は、コントローラーとホスト間の最適化されたパスを特定し、パフォーマンスを向上させます。

ネイティブ NVMe マルチパスを有効にすると、すべての NVMe デバイスにグローバルに適用されます。より高いパフォーマンスを提供できますが、DM Multipath が提供するすべての機能は含まれていません。例えば、ネイティブの NVMe マルチパスは、numa と round-robin のパス選択方法のみをサポートしています。

デフォルトでは、NVMe マルチパスは Red Hat Enterprise Linux 9 で有効になっており、これは推奨されるマルチパスソリューションです。

13.2. NVMe デバイスでの DM Multipath の有効化

nvme_core.multipath オプションのデフォルトのカーネル設定は Y に設定されています。これは、ネイティブ Non-volatile Memory Express™ (NVMe™) マルチパスが有効であることを意味します。ネイティブ NVMe マルチパスを無効にすることで、接続された NVMe デバイスで DM マルチパスを有効にできます。

前提条件

- NVMe デバイスがシステムに接続されていることを確認します。詳細は、NVMe over fabric デバイスの概要 を参照してください。

手順

ネイティブ NVMe マルチパスが有効になっているかどうかを確認します。

# cat /sys/module/nvme_core/parameters/multipathコマンドは以下のいずれかを表示します。

N- ネイティブ NVMe マルチパスは無効です。

Y- ネイティブ NVMe マルチパスは有効です。

ネイティブ NVMe マルチパスが有効になっている場合は、次のいずれかの方法を使用して無効にします。

カーネルオプションの使用

nvme_core.multipath=Nオプションをコマンドラインに追加します。# grubby --update-kernel=ALL --args="nvme_core.multipath=N"64 ビットの IBM Z アーキテクチャーでは、ブートメニューを更新します。

# zipl- システムを再起動します。

カーネルモジュール設定ファイルの使用

以下の内容で

/etc/modprobe.d/nvme_core.conf設定ファイルを作成します。options nvme_core multipath=N

initramfsファイルをバックアップします。# cp /boot/initramfs-$(uname -r).img /boot/initramfs-$(uname -r).bak.$(date +%m%d-%H%M%S).imginitramfsを再構築します。# cp /boot/initramfs-$(uname -r).img /boot/initramfs-$(uname -r).bak.$(date +%m-%d-%H%M%S).img # dracut --force --verbose

- システムを再起動します。

DM マルチパスを有効にします。

# systemctl enable --now multipathd.service利用可能なすべてのパスに I/O を分配します。

/etc/multipath.confファイルに以下の内容を追加します。devices { device { vendor "NVME" product ".*" path_grouping_policy group_by_prio } }注記DM Multipath が NVMe デバイスを管理する場合、

/sys/class/nvme-subsystem/nvme-subsys0/iopolicy設定ファイルは I/O ディストリビューションには影響を与えません。設定の変更を適用するために、

multipathdサービスをリロードします。# multipath -r

検証

ネイティブ NVMe マルチパスが無効になっているかどうかを確認します。

# cat /sys/module/nvme_core/parameters/multipath NDM マルチパスが NVMe デバイスを認識しているかどうかを確認します。

# multipath -l eui.00007a8962ab241100a0980000d851c8 dm-6 NVME,NetApp E-Series size=20G features='0' hwhandler='0' wp=rw `-+- policy='service-time 0' prio=0 status=active |- 0:10:2:2 nvme0n2 259:3 active undef running `-+- policy='service-time 0' prio=0 status=enabled |- 4:11:2:2 nvme4n2 259:28 active undef running `-+- policy='service-time 0' prio=0 status=enabled |- 5:32778:2:2 nvme5n2 259:38 active undef running `-+- policy='service-time 0' prio=0 status=enabled |- 6:32779:2:2 nvme6n2 259:44 active undef running

13.3. ネイティブ NVMe マルチパスの実現

ネイティブ NVMe マルチパスが無効になっている場合は、次の解決策を使用して有効にできます。

前提条件

- NVMe デバイスがシステムに接続されていることを確認します。詳細は、NVMe over fabric デバイスの概要 を参照してください。

手順

カーネルでネイティブ NVMe マルチパスが有効になっているかどうかを確認します。

# cat /sys/module/nvme_core/parameters/multipathコマンドは以下のいずれかを表示します。

N- ネイティブ NVMe マルチパスは無効です。

Y- ネイティブ NVMe マルチパスは有効です。

ネイティブ NVMe マルチパスが無効になっている場合は、次のいずれかの方法を使用して有効にします。

カーネルオプションの使用

カーネルコマンドラインから

nvme_core.multipath=Nオプションを削除します。# grubby --update-kernel=ALL --remove-args="nvme_core.multipath=N"64 ビットの IBM Z アーキテクチャーでは、ブートメニューを更新します。

# zipl- システムを再起動します。

カーネルモジュール設定ファイルの使用

/etc/modprobe.d/nvme_core.conf設定ファイルを削除します。# rm /etc/modprobe.d/nvme_core.confinitramfsファイルをバックアップします。# cp /boot/initramfs-$(uname -r).img /boot/initramfs-$(uname -r).bak.$(date +%m-%d-%H%M%S).imginitramfsを再構築します。# dracut --force --verbose- システムを再起動します。

オプション: 実行中のシステムで、NVMe デバイスの I/O ポリシーを変更して、利用可能なすべてのパスに I/O を分散させます。

# echo "round-robin" > /sys/class/nvme-subsystem/nvme-subsys0/iopolicyオプション:

udevルールを使用して I/O ポリシーを永続的に設定します。以下の内容で/etc/udev/rules.d/71-nvme-io-policy.rulesファイルを作成します。ACTION=="add|change", SUBSYSTEM=="nvme-subsystem", ATTR{iopolicy}="round-robin"

検証

システムが NVMe デバイスを認識しているかどうかを確認します。次の例は、2 つの NVMe 名前空間を持つ NVMe over fabrics ストレージサブシステムが接続されていることを想定しています:

# nvme list Node SN Model Namespace Usage Format FW Rev ---------------- -------------------- ---------------------------------------- --------- -------------------------- ---------------- -------- /dev/nvme0n1 a34c4f3a0d6f5cec Linux 1 250.06 GB / 250.06 GB 512 B + 0 B 4.18.0-2 /dev/nvme0n2 a34c4f3a0d6f5cec Linux 2 250.06 GB / 250.06 GB 512 B + 0 B 4.18.0-2接続されているすべての NVMe サブシステムをリストアップします。

# nvme list-subsys nvme-subsys0 - NQN=testnqn \ +- nvme0 fc traddr=nn-0x20000090fadd597a:pn-0x10000090fadd597a host_traddr=nn-0x20000090fac7e1dd:pn-0x10000090fac7e1dd live +- nvme1 fc traddr=nn-0x20000090fadd5979:pn-0x10000090fadd5979 host_traddr=nn-0x20000090fac7e1dd:pn-0x10000090fac7e1dd live +- nvme2 fc traddr=nn-0x20000090fadd5979:pn-0x10000090fadd5979 host_traddr=nn-0x20000090fac7e1de:pn-0x10000090fac7e1de live +- nvme3 fc traddr=nn-0x20000090fadd597a:pn-0x10000090fadd597a host_traddr=nn-0x20000090fac7e1de:pn-0x10000090fac7e1de liveアクティブトランスポートタイプを確認します。例えば、

nvme0 fcはファイバーチャネルトランスポートで接続されていることを示し、nvme tcpは TCP で接続されていることを示しています。カーネルオプションを編集した場合は、カーネルコマンドラインでネイティブ NVMe マルチパスが有効になっているかどうかを確認します。

# cat /proc/cmdline BOOT_IMAGE=[...] nvme_core.multipath=YI/O ポリシーを変更した場合は、NVMe デバイス上で

round-robinがアクティブな I/O ポリシーであるかどうかを確認します。# cat /sys/class/nvme-subsystem/nvme-subsys0/iopolicy round-robin

関連情報

第14章 リモートディスクレスシステムの設定

ネットワーク環境では、リモートディスクレスシステムをデプロイすることで、同一の設定で複数のクライアントをセットアップできます。現在の Red Hat Enterprise Linux サーバーバージョンを使用すると、これらのクライアントのハードドライブのコストを節約できるだけでなく、別のサーバーにゲートウェイを設定することもできます。

次の図は、Dynamic Host Configuration Protocol (DHCP) および Trivial File Transfer Protocol (TFTP) サービスを介したディスクレスクライアントとサーバーの接続を示しています。

図14.1 リモートディスクレスシステム設定のダイアグラム

14.1. リモートディスクレスシステムの環境の準備

リモートディスクレスシステムの実装を続行できるように環境を準備します。リモートディスクレスシステムの起動には次のサービスが必要です。

- tftp-server によって提供される Trivial File Transfer Protocol (TFTP) サービス。システムは、tftp サービスを使用して、Preboot Execution Environment (PXE) ローダーを通じてネットワーク経由でカーネルイメージと初期 RAM ディスク initrd を取得します。

- dhcp によって提供される Dynamic Host Configuration Protocol (DHCP) サービス。

前提条件

- ネットワーク接続が設定されている。

手順

dracut-networkパッケージをインストールします。# dnf install dracut-network/etc/dracut.conf.d/network.confファイルに次の行を追加します。add_dracutmodules+=" nfs "

次の順序でサービスを設定して、環境内のリモートディスクレスシステムが正しく機能するようにします。

- TFTP サービスを設定します。詳細は、ディスクレスクライアントの TFTP サービスの設定 を参照してください。

- DHCP サーバーを設定します。詳細は、ディスクレスクライアントの DHCP サーバーの設定 を参照してください。

- ネットワークファイルシステム (NFS) とエクスポートしたファイルシステムを設定します。詳細は、ディスクレスクライアントのエクスポートしたファイルシステムの設定 を参照してください。

14.2. ディスクレスクライアントの TFTP サービスの設定

リモートディスクレスシステムを環境内で正しく機能させるには、まずディスクレスクライアントの Trivial File Transfer Protocol (TFTP) サービスを設定する必要があります。

この設定は、Unified Extensible Firmware Interface (UEFI) 経由では起動しません。UEFI ベースのインストールの場合は、UEFI ベースのクライアント向けに TFTP サーバーを設定する を参照してください。

前提条件

次のパッケージがインストールされている。

-

tftp-server -

syslinux

-

手順

TFTPサービスを有効にします。# systemctl enable --now tftptftpのルートディレクトリーにpxelinuxディレクトリーを作成します。# mkdir -p /var/lib/tftpboot/pxelinux//usr/share/syslinux/pxelinux.0ファイルを/var/lib/tftpboot/pxelinux/ディレクトリーにコピーします。# cp /usr/share/syslinux/pxelinux.0 /var/lib/tftpboot/pxelinux//usr/share/syslinux/ldlinux.c32を/var/lib/tftpboot/pxelinux/にコピーします。# cp /usr/share/syslinux/ldlinux.c32 /var/lib/tftpboot/pxelinux/tftpのルートディレクトリーにpxelinux.cfgディレクトリーを作成します。# mkdir -p /var/lib/tftpboot/pxelinux/pxelinux.cfg/

検証

サービス

tftpのステータスを確認します。# systemctl status tftp ... Active: active (running) ...

14.3. ディスクレスクライアントの DHCP サーバーの設定

リモートディスクレスシステムが正しく機能するには、いくつかのプリインストールされたサービスが必要です。

前提条件

- Trivial File Transfer Protocol (TFTP) サービスがインストールされている。

次のパッケージがインストールされている。

-

dhcp-server

-

-

ディスクレスクライアントの

tftpサービスが設定されている。詳細は、ディスクレスクライアントの TFTP サービスの設定 を参照してください。

手順

/etc/dhcp/dhcpd.confファイルに次の設定を追加して、DHCP サーバーをセットアップし、ブート用の Preboot Execution Environment (PXE) を有効にします。option space pxelinux; option pxelinux.magic code 208 = string; option pxelinux.configfile code 209 = text; option pxelinux.pathprefix code 210 = text; option pxelinux.reboottime code 211 = unsigned integer 32; option architecture-type code 93 = unsigned integer 16; subnet 192.168.205.0 netmask 255.255.255.0 { option routers 192.168.205.1; range 192.168.205.10 192.168.205.25; class "pxeclients" { match if substring (option vendor-class-identifier, 0, 9) = "PXEClient"; next-server 192.168.205.1; if option architecture-type = 00:07 { filename "BOOTX64.efi"; } else { filename "pxelinux/pxelinux.0"; } } }DHCP 設定は、リース時間や固定アドレスの設定など、環境によって異なる場合があります。詳細は、DHCP サービスの提供 を参照してください。

注記libvirt仮想マシンをディスクレスクライアントとして使用する場合、libvirtデーモンが DHCP サービスを提供し、スタンドアロン DHCP サーバーは使用されません。この状況では、libvirtネットワーク設定のvirsh net-editでbootp file=<filename>オプションを使用して、ネットワークブートを有効にする必要があります。dhcpd.serviceを有効にします。# systemctl enable --now dhcpd.service

検証

サービス

dhcpd.serviceのステータスを確認します。# systemctl status dhcpd.service ... Active: active (running) ...

14.4. ディスクレスクライアントのエクスポートしたファイルシステムの設定

環境にリモートディスクレスシステムを設定する一環として、ディスクレスクライアント用にエクスポートしたファイルシステムを設定する必要があります。

前提条件

-

ディスクレスクライアントの

tftpサービスが設定されている。ディスクレスクライアントの TFTP サービスの設定 セクションを参照してください。 - Dynamic Host Configuration Protocol (DHCP) サーバーが設定されている。ディスクレスクライアントの DHCP サーバーの設定 セクションを参照してください。

手順

-

/etc/exportsディレクトリーにルートディレクトリーを追加して、ルートディレクトリーをエクスポートするようにネットワークファイルシステム (NFS) サーバーを設定します。手順の詳細は、NFS サーバーのデプロイ を参照してください。 完全にディスクレスのクライアントに対応できるように、Red Hat Enterprise Linux の完全なバージョンをルートディレクトリーにインストールします。これを行うには、新しいベースシステムをインストールするか、既存のインストールのクローンを作成します。

exported-root-directory をエクスポートしたファイルシステムへのパスに置き換えて、エクスポートした場所に Red Hat Enterprise Linux をインストールします。

# dnf install @Base kernel dracut-network nfs-utils --installroot=exported-root-directory --releasever=/releaseverオプションを/に設定すると、releasever がホスト (/) システムから検出されます。rsyncユーティリティーを使用して、実行中のシステムと同期します。# rsync -a -e ssh --exclude='/proc/' --exclude='/sys/' example.com:/ exported-root-directory-

example.com は、

rsyncユーティリティーで同期する実行中のシステムのホスト名に置き換えます。 exported-root-directory を、エクスポートしたファイルシステムへのパスに置き換えます。

このオプションには、実行中の別のシステムが必要です。これは、このコマンドでサーバーにクローンを作成します。

-

example.com は、

ファイルシステムをディスクレスクライアントで使用する前に、エクスポートの準備が完了しているファイルシステムを設定します。

ディスクレスクライアントがサポートするカーネル (

vmlinuz-_kernel-version_pass:attributes) をtftpブートディレクトリーにコピーします。# cp /exported-root-directory/boot/vmlinuz-kernel-version /var/lib/tftpboot/pxelinux/initramfs-kernel-version.imgファイルをローカルに作成し、NFS をサポートするエクスポートされたルートディレクトリーに移動します。# dracut --add nfs initramfs-kernel-version.img kernel-version以下に例を示します。

# dracut --add nfs /exports/root/boot/initramfs-5.14.0-202.el9.x86_64.img 5.14.0-202.el9.x86_64現在実行中のカーネルバージョンを使用し、既存のイメージを上書きして initrd を作成する例を以下に示します。

# dracut -f --add nfs "boot/initramfs-$(uname -r).img" "$(uname -r)"initrdのファイル権限を0644に変更します。# chmod 0644 /exported-root-directory/boot/initramfs-kernel-version.img警告initrdのファイル権限を変更しないと、pxelinux.0ブートローダーが "file not found" エラーを表示して失敗します。作成された

initramfs-kernel-version.imgファイルをtftpブートディレクトリーにコピーします。# cp /exported-root-directory/boot/initramfs-kernel-version.img /var/lib/tftpboot/pxelinux//var/lib/tftpboot/pxelinux/pxelinux.cfg/defaultファイルに次の設定を追加して、initrdとカーネルを使用するためのデフォルトのブート設定を編集します。default rhel9 label rhel9 kernel vmlinuz-kernel-version append initrd=initramfs-kernel-version.img root=nfs:_server-ip_:/exported-root-directory rw

この設定は、ディスクレスクライアントのルートに、

/exported-root-directoryエクスポートファイルシステムを読み取り/書き込み形式でマウントするように指示します。オプション:

/var/lib/tftpboot/pxelinux/pxelinux.cfg/defaultファイルを次の設定で編集して、ファイルシステムをread-only形式でマウントします。default rhel9 label rhel9 kernel vmlinuz-kernel-version append initrd=initramfs-kernel-version.img root=nfs:server-ip:/exported-root-directory ro

NFS サーバーを再起動します。

# systemctl restart nfs-server.service

これで、NFS 共有をディスクレスクライアントにエクスポートできるようになりました。これらのクライアントは、Preboot Execution Environment (PXE) 経由でネットワーク経由で起動できます。

14.5. リモートディスクレスシステムの再設定

パッケージのインストール、サービスの再起動、または問題のデバッグを行う場合は、システムを再設定できます。

前提条件

-

エクスポートしたファイルシステムで

no_root_squashオプションが有効になっている。

手順

ユーザーパスワードを変更します。

コマンドラインを /exported/root/directory に変更します。

# chroot /exported/root/directory /bin/bash必要なユーザーのパスワードを変更します。

# passwd <username><username> は、パスワードを変更する実際のユーザーに置き換えます。

- コマンドラインを終了します。

リモートディスクレスシステムにソフトウェアをインストールします。

# dnf install <package> --installroot=/exported/root/directory --releasever=/ --config /etc/dnf/dnf.conf --setopt=reposdir=/etc/yum.repos.d/<package> を、インストールする実際のパッケージに置き換えます。

- 2 つの個別のエクスポートを設定して、リモートディスクレスシステムを /usr と /var に分割します。詳細は、NFS サーバーのデプロイ を参照してください。

14.6. リモートディスクレスシステムのロードに関する一般的な問題のトラブルシューティング

以前の設定を利用すると、リモートディスクレスシステムのロード中に問題が発生する可能性があります。以下に、Red Hat Enterprise Linux サーバーで最も一般的な問題とそのトラブルシューティングの例をいくつか示します。

例14.1 クライアントが IP アドレスを取得しない

サーバー上で Dynamic Host Configuration Protocol (DHCP) サービスが有効になっているかどうかを確認します。

dhcp.serviceが実行しているかどうかを確認します。# systemctl status dhcpd.servicedhcp.serviceが非アクティブな場合は、有効にして起動します。# systemctl enable dhcpd.service # systemctl start dhcpd.service

- ディスクレスクライアントを再起動します。

-

DHCP 設定ファイル

/etc/dhcp/dhcpd.confを確認します。詳細は、ディスクレスクライアントの DHCP サーバーの設定 を参照してください。

ファイアウォールポートが開いているかどうかを確認します。

dhcp.serviceがアクティブなサービスにリストされているかどうかを確認します。# firewall-cmd --get-active-zones # firewall-cmd --info-zone=public

dhcp.serviceがアクティブなサービスにリストされていない場合は、リストに追加します。# firewall-cmd --add-service=dhcp --permanentnfs.serviceがアクティブなサービスに記載されているかどうかを確認します。# firewall-cmd --get-active-zones # firewall-cmd --info-zone=public

nfs.serviceがアクティブなサービスに記載されていない場合は、これをリストに追加します。# firewall-cmd --add-service=nfs --permanent

例14.2 リモートディスクレスシステムの起動時にファイルを使用できない

-

ファイルが

/var/lib/tftpboot/ディレクトリーにあるかどうかを確認します。 ファイルがディレクトリー内にある場合は、ファイルに次の権限があるかどうかを確認します。

# chmod 644 pxelinux.0- ファイアウォールポートが開いているかどうかを確認します。

例14.3 kernel/initrd のロード後にシステムの起動に失敗した

サーバーで NFS サービスが有効になっているかどうかを確認します。

nfs.serviceが実行中かどうかを確認します。# systemctl status nfs.servicenfs.serviceが非アクティブな場合は、それを起動して有効にする必要があります。# systemctl start nfs.service # systemctl enable nfs.service

-

/var/lib/tftpboot/pxelinux.cfg/ディレクトリーでパラメーターが正しいかどうかを確認してください。詳細は、ディスクレスクライアントのエクスポートしたファイルシステムの設定 を参照してください。 - ファイアウォールポートが開いているかどうかを確認します。

第15章 スワップの使用

スワップ領域を使用して、非アクティブなプロセスとデータに一時的なストレージを提供し、物理メモリーがいっぱいになった場合に発生するメモリー不足エラーを防ぎます。スワップ領域は物理メモリーの拡張として機能し、物理メモリーが使い果たされた場合でもシステムがスムーズに動作し続けることを可能にします。スワップ領域を使用するとシステムのパフォーマンスが低下する可能性があるため、スワップ領域を利用する前に物理メモリーの使用を最適化するほうが望ましい場合があることに注意してください。

15.1. スワップ領域の概要

Linux の スワップ領域 は、物理メモリー (RAM) が不足すると使用されます。システムに多くのメモリーリソースが必要で、RAM が不足すると、メモリーの非アクティブなページがスワップ領域に移動します。スワップ領域は、RAM が少ないマシンで役に立ちますが、RAM の代わりに使用しないようにしてください。

スワップ領域はハードドライブにあり、そのアクセス速度は物理メモリーに比べると遅くなります。スワップ領域の設定は、専用のスワップパーティション (推奨)、スワップファイル、またはスワップパーティションとスワップファイルの組み合せが考えられます。

過去数年、推奨されるスワップ領域のサイズは、システムの RAM サイズに比例して増加していました。しかし、最近のシステムには通常、数百ギガバイトの RAM が含まれます。結果として、推奨されるスワップ領域は、システムのメモリーではなく、システムメモリーのワークロードの機能とみなされます。

15.2. システムの推奨スワップ領域

推奨されるスワップパーティションのサイズは、システムの RAM の容量と、システムをハイバネートするのに十分なメモリーが必要かどうかによって異なります。推奨されるスワップパーティションのサイズは、インストール時に自動的に設定されます。ハイバネートを可能にするには、カスタムのパーティション分割段階でスワップ領域を編集する必要があります。

以下の推奨は、1 GB 以下など、メモリーが少ないシステムで特に重要です。このようなシステムで十分なスワップ領域を割り当てられないと、システムが不安定になったり、インストールしたシステムが起動できなくなったりする可能性があります。

| システム内の RAM の容量 | 推奨されるスワップ領域 | ハイバネートを許可する場合に推奨されるスワップ領域 |

|---|---|---|

| ⩽ 2 GB | RAM 容量の 2 倍 | RAM 容量の 3 倍 |

| > 2 GB - 8 GB | RAM 容量と同じ | RAM 容量の 2 倍 |

| > 8 GB - 64 GB | 最低 4GB | RAM 容量の 1.5 倍 |

| > 64 GB | 最低 4GB | ハイバネートは推奨されない |

システム RAM が 2 GB、8 GB、または 64 GB などの境界値の場合は、必要に応じてスワップサイズを選択してください。システムリソースに余裕がある場合は、スワップ領域を増やすとパフォーマンスが向上することがあります。

高速のドライブ、コントローラー、およびインターフェイスを搭載したシステムでは、複数のストレージデバイスにスワップ領域を分散すると、スワップ領域のパフォーマンスも向上します。

スワップ領域として割り当てたファイルシステムおよび LVM2 ボリュームは、変更時に 使用しない でください。システムプロセスまたはカーネルがスワップ領域を使用していると、スワップの修正に失敗します。free コマンドおよび cat /proc/swaps コマンドを使用して、スワップの使用量と、使用中の場所を確認します。

スワップ領域のサイズを変更するには、システムから一時的にスワップ領域を削除する必要があります。これは、実行中のアプリケーションが追加のスワップ領域に依存し、メモリーが不足する可能性がある場合に問題になる可能性があります。できれば、レスキューモードからスワップのサイズ変更を実行してください。デバッグ起動オプション を参照してください。ファイルシステムをマウントするように指示されたら、 を選択します。

15.3. スワップ用の LVM2 論理ボリュームの作成

スワップ用の LVM2 論理ボリュームを作成できます。ここでは、追加するスワップボリュームを /dev/VolGroup00/LogVol02 とします。

前提条件

- 十分なディスク領域がある。

手順

サイズが 2 GB の LVM2 論理ボリュームを作成します。

# lvcreate VolGroup00 -n LogVol02 -L 2G新しいスワップ領域をフォーマットします。

# mkswap /dev/VolGroup00/LogVol02次のエントリーを

/etc/fstabファイルに追加します。/dev/VolGroup00/LogVol02 none swap defaults 0 0システムが新しい設定を登録するように、マウントユニットを再生成します。

# systemctl daemon-reload論理ボリュームでスワップをアクティブにします。

# swapon -v /dev/VolGroup00/LogVol02

検証

スワップ論理ボリュームが正常に作成され、アクティブになったかをテストするには、次のコマンドを使用して、アクティブなスワップ領域を調べます。

# cat /proc/swaps total used free shared buff/cache available Mem: 30Gi 1.2Gi 28Gi 12Mi 994Mi 28Gi Swap: 22Gi 0B 22Gi# free -h total used free shared buff/cache available Mem: 30Gi 1.2Gi 28Gi 12Mi 995Mi 28Gi Swap: 17Gi 0B 17Gi

15.4. スワップファイルの作成

システムのメモリーが不足しているときに、スワップファイルを作成して、ソリッドステートドライブまたはハードディスク上に一時的なストレージ領域を作成できます。

前提条件

- 十分なディスク領域がある。

手順

- 新しいスワップファイルのサイズをメガバイト単位で指定してから、そのサイズに 1024 をかけてブロック数を指定します。たとえばスワップファイルのサイズが 64 MB の場合は、ブロック数が 65536 になります。