配置和管理网络

管理网络接口和高级网络功能

摘要

- 您可以配置绑定、VLAN、网桥、隧道和其他网络类型,以将主机连接到网络。

- IPsec 和 WireGuard 在主机和网络之间提供安全 VPN。

- RHEL 还支持高级网络功能,如基于策略的路由和多路径 TCP (MPTCP)。

对红帽文档提供反馈

我们感谢您对我们文档的反馈。让我们了解如何改进它。

通过 Jira 提交反馈(需要帐户)

- 登录到 Jira 网站。

- 点顶部导航栏中的 Create

- 在 Summary 字段中输入描述性标题。

- 在 Description 字段中输入您对改进的建议。包括文档相关部分的链接。

- 点对话框底部的 Create。

第 1 章 实施一致的网络接口命名

udev 设备管理器在 Red Hat Enterprise Linux 中实施一致的设备命名。设备管理器支持不同的命名方案,默认情况下,根据固件、拓扑和位置信息分配固定的名称。

如果没有一致的设备命名,Linux 内核通过组合固定的前缀和索引来为网络接口分配名称。当内核初始化网络设备时,索引会增加。例如:eth0 代表启动时探测到的第一个以太网设备。如果您在系统中添加了另一个网络接口控制器,则内核设备名称的分配不再是固定的,因为重启后,设备可以以不同的方式初始化。在这种情况下,内核可以以不同的方式命名设备。

要解决这个问题,udev 分配一致的设备名称。它有以下优点:

- 设备名称在重启时是稳定的。

- 即使添加或删除硬件,设备名称也会保持不变。

- 因此,有问题的硬件可以被无缝地替换。

- 网络命名是无状态的,不需要显式的配置文件。

通常,红帽不支持禁用了一致设备命名的系统。有关例外情况,请参阅红帽知识库解决方案 可以安全地设置 net.ifnames=0 吗。

1.1. udev 设备管理器如何重命名网络接口

要为网络接口实施一致的命名方案,udev 设备管理器按列出的顺序处理以下规则文件:

可选:

/usr/lib/udev/rules.d/60-net.rules只有在安装

initscripts-rename-device软件包时,该文件才存在。定义了弃用的/usr/lib/udev/rename_device助手工具的/usr/lib/udev/rules.d/60-net.rules文件在/etc/sysconfig/network-scripts/ifcfg-*文件中查找HWADDR参数。如果变量中设置的值与接口的 MAC 地址匹配,则助手工具会将接口重命名为ifcfg文件的DEVICE参数中设置的名称。如果系统只使用 keyfile 格式的 NetworkManager 连接配置文件,则

udev会跳过这一步。只在 Dell 系统上:

/usr/lib/udev/rules.d/71-biosdevname.rules只有安装了

biosdevname软件包,该文件才存在,如果没有在之前的步骤中重命名,定义了biosdevname工具的规则文件会根据其命名策略重命名接口。注意仅在 Dell 系统上安装和使用

biosdevname。/usr/lib/udev/rules.d/75-net-description.rules此文件定义

udev如何检查网络接口,并在udev-internal 变量中设置属性。然后,这些变量被/usr/lib/udev/rules.d/80-net-setup-link.rules文件在下一步中处理。其中一些属性可以是未定义。/usr/lib/udev/rules.d/80-net-setup-link.rules此文件调用

udev服务的net_setup_link内置,并且udev根据/usr/lib/systemd/network/99-default.link文件中NamePolicy参数中策略的顺序来重命名接口。详情请查看 网络接口命名策略。如果没有应用任何策略,则

udev不会重命名接口。

其他资源

1.2. 网络接口命名策略

默认情况下,udev 设备管理器使用 /usr/lib/systemd/network/99-default.link 文件来确定在重命名接口时要应用哪个设备命名策略。此文件中的 NamePolicy 参数定义 udev 使用哪些策略以及按什么顺序:

NamePolicy=keep kernel database onboard slot path

下表根据哪个策略与 NamePolicy 参数指定的首先匹配,描述了 udev 的不同操作:

| policy | 描述 | 名称示例 |

|---|---|---|

| keep |

如果设备在用户空间中已有分配的名称,则 | |

| kernel |

如果内核表示设备名称是可预测的,则 |

|

| database |

此策略根据 |

|

| onboard | 设备名称包含固件或者 BIOS 提供的索引号,用于板上的设备。 |

|

| slot | 设备名称包含固件或 BIOS 提供的 PCI Express (PCIe)热插拔 slot-index 号。 |

|

| path | 设备名称包含硬件连接器的物理位置。 |

|

| mac | 设备名称包含 MAC 地址。默认情况下,Red Hat Enterprise Linux 不使用此策略,但管理员可以启用它。 |

|

其他资源

- udev 设备管理器如何重命名网络接口

-

您系统上的

systemd.link (5)手册页

1.3. 网络接口命名方案

udev 设备管理器使用设备驱动程序提供的某些稳定的接口属性,来生成一致的设备名称。

如果新的 udev 版本更改了服务如何为某些接口创建名称的方式,红帽会添加一个新的方案版本,并在您系统上的 systemd.net-naming-scheme (7) 手册页中记录详细信息。默认情况下,Red Hat Enterprise Linux (RHEL) 9 使用 rhel-9.0 命名方案,即使您安装或升级到更新的 RHEL 次版本。

为了防止新驱动程序为网络接口提供更多或其他属性,rhel-net-naming-sysattrs 软件包提供了 /usr/lib/udev/hwdb.d/50-net-naming-sysattr-allowlist.hwdb 数据库。此数据库定义了 udev 服务可使用哪些 sysfs 值来创建网络接口名称。数据库中的条目也是版本控制的,并受到方案版本影响。

在 RHEL 9.4 及更高版本上,您还可以使用所有 rhel-8.* 命名方案。

如果要使用默认方案以外的方案,您可以 切换网络接口命名方案。

有关不同设备类型和平台的命名方案的详情,请查看您系统上的 systemd.net-naming-scheme (7) 手册页。

1.4. 切换到不同的网络接口命名方案

默认情况下,Red Hat Enterprise Linux (RHEL) 9 使用 rhel-9.0 命名方案,即使您安装或升级到更新的 RHEL 次版本。虽然默认的命名方案适合大多数情况,但可能有切换到不同的方案版本的理由,例如:

- 如果其向接口名称添加了额外的属性(如插槽号),则新方案可以帮助更好地识别设备。

-

新方案可以防止

udev回退到内核分配的设备名称(eth*)。如果驱动程序没有为两个或多个接口提供足够的唯一属性,来为它们生成唯一名称,则会发生这种情况。

先决条件

- 您可以访问服务器的控制台。

步骤

列出网络接口:

# ip link show 2: eno1: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc fq_codel state UP mode DEFAULT group default qlen 1000 link/ether 00:00:5e:00:53:1a brd ff:ff:ff:ff:ff:ff ...记录接口的 MAC 地址。

可选:显示网络接口的

ID_NET_NAMING_SCHEME属性,来识别 RHEL 当前使用的命名方案:# udevadm info --query=property --property=ID_NET_NAMING_SCHEME /sys/class/net/eno1' ID_NET_NAMING_SCHEME=rhel-9.0请注意,属性在

loloopback 设备上不可用。将

net.naming-scheme=<scheme>选项附加到所有安装的内核的命令行中,例如:# grubby --update-kernel=ALL --args=net.naming-scheme=rhel-9.4重启系统。

# reboot根据您记录的 MAC 地址,识别因不同的命名方案而更改的网络接口的新名称:

# ip link show 2: eno1np0: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc fq_codel state UP mode DEFAULT group default qlen 1000 link/ether 00:00:5e:00:53:1a brd ff:ff:ff:ff:ff:ff ...切换方案后,在这个示例中,

udev将 MAC 地址为00:00:5e:00:53:1a的设备命名为eno1np0,而之前其被命名为eno1。确定哪个 NetworkManager 连接配置文件使用之前名称的接口:

# nmcli -f device,name connection show DEVICE NAME eno1 example_profile ...将连接配置文件中的

connection.interface-name属性设置为新接口名称:# nmcli connection modify example_profile connection.interface-name "eno1np0"重新激活连接配置文件:

# nmcli connection up example_profile

验证

通过显示网络接口的

ID_NET_NAMING_SCHEME属性来识别 RHEL 现在使用的命名方案:# udevadm info --query=property --property=ID_NET_NAMING_SCHEME /sys/class/net/eno1np0' ID_NET_NAMING_SCHEME=_rhel-9.4

其他资源

1.5. 在安装过程中自定义以太网接口的前缀

如果您不想将默认的设备命名策略用于以太网接口,您可以在 Red Hat Enterprise Linux (RHEL)安装过程中设置一个自定义设备前缀。

只有您在 RHEL 安装过程中设置了前缀时,红帽才支持带有自定义以太网前缀的系统。不支持在已部署的系统上使用 prefixdevname 工具。

如果您在安装过程中设置了设备前缀,则 udev 服务会在安装后为以太网接口使用<prefix><index>格式。例如,如果您设置了前缀 net,服务会将名称 net0、net1 等分配给以太网接口。

udev 服务将索引附加到自定义前缀,并保留已知以太网接口的索引值。如果您添加了一个接口,udev 会为新接口分配一个比之前分配的索引值大的索引值。

先决条件

- 前缀由 ASCII 字符组成。

- 前缀是一个字母数字字符串。

- 前缀少于 16 个字符。

-

前缀不会与任何其他已知的网络接口前缀冲突,如

eth、eno、ens、em。

步骤

- 引导 Red Hat Enterprise Linux 安装介质。

在引导管理器中,按照以下步骤操作:

-

选择

Install Red Hat Enterprise Linux <version>条目。 - 按 Tab 编辑条目。

-

将

net.ifnames.prefix=<prefix>追加到在内核选项中。 - 按 Enter 键启动安装程序。

-

选择

- 安装 Red Hat Enterprise Linux。

验证

要验证接口名称,显示网络接口:

# ip link show ... 2: net0: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc fq_codel state UP mode DEFAULT group default qlen 1000 link/ether 00:00:5e:00:53:1a brd ff:ff:ff:ff:ff:ff ...

其他资源

1.6. 使用 udev 规则配置用户定义的网络接口名称

您可以使用 udev 规则来实现反映您机构的要求的自定义网络接口名称。

流程

识别您要重命名的网络接口:

# ip link show ... enp1s0: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc fq_codel state UP mode DEFAULT group default qlen 1000 link/ether 00:00:5e:00:53:1a brd ff:ff:ff:ff:ff:ff ...记录接口的 MAC 地址。

显示接口的设备类型 ID:

# cat /sys/class/net/enp1s0/type 1创建

/etc/udev/rules.d/70-persistent-net.rules文件,并为您要重命名的每个接口添加一个规则:SUBSYSTEM=="net",ACTION=="add",ATTR{address}=="<MAC_address>",ATTR{type}=="<device_type_id>",NAME="<new_interface_name>"重要如果您在引导过程中需要一致的设备名称,则只使用

70-persistent-net.rules作为文件名。如果您重新生成 RAM 磁盘镜像,则dracut工具会在initrd镜像中添加一个具有此名称的文件。例如,使用以下规则将 MAC 地址为

00:00:5e:00:53:1a的接口重命名为provider0:SUBSYSTEM=="net",ACTION=="add",ATTR{address}=="00:00:5e:00:53:1a",ATTR{type}=="1",NAME="provider0"可选:重新生成

initrdRAM 磁盘镜像:# dracut -f只有在 RAM 磁盘中需要网络功能时才需要这一步。例如,如果根文件系统存储在网络设备上,如 iSCSI,则会出现这种情况。

确定哪个 NetworkManager 连接配置文件使用您要重命名的接口:

# nmcli -f device,name connection show DEVICE NAME enp1s0 example_profile ...在连接配置文件中取消

connection.interface-name属性的设置:# nmcli connection modify example_profile connection.interface-name ""临时配置连接配置文件,以匹配新的和以前的接口名称:

# nmcli connection modify example_profile match.interface-name "provider0 enp1s0"重启系统:

# reboot验证具有您在链接文件中指定的 MAC 地址的设备是否已被重命名为

provider0:# ip link show provider0: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc mq state UP mode DEFAULT group default qlen 1000 link/ether 00:00:5e:00:53:1a brd ff:ff:ff:ff:ff:ff ...配置连接配置文件,以仅匹配新接口名称:

# nmcli connection modify example_profile match.interface-name "provider0"现在,您已经从连接配置文件中删除了旧接口名称。

重新激活连接配置文件:

# nmcli connection up example_profile

其他资源

-

您系统上的

udev (7)手册页

1.7. 使用 systemd 链接文件配置用户定义的网络接口名称

您可以使用 systemd 链接文件来实现反映您机构要求的自定义网络接口名称。

先决条件

- 您必须满足这些条件之一:NetworkManager 不管理这个接口,或者对应的连接配置文件使用 keyfile 格式。

流程

识别您要重命名的网络接口:

# ip link show ... enp1s0: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc fq_codel state UP mode DEFAULT group default qlen 1000 link/ether 00:00:5e:00:53:1a brd ff:ff:ff:ff:ff:ff ...记录接口的 MAC 地址。

如果其不存在,请创建

/etc/systemd/network/目录:# mkdir -p /etc/systemd/network/对于您要重命名的每个接口,请在

/etc/systemd/network/目录中创建一个具有以下内容的70-*.link文件:[Match] MACAddress=<MAC_address> [Link] Name=<new_interface_name>

重要使用一个具有

70前缀的文件名,使文件名与udev规则的解决方案一致。例如,使用以下内容创建

/etc/systemd/network/70-provider0.link文件,将 MAC 地址为00:00:5e:00:53:1a的接口重命名为provider0:[Match] MACAddress=00:00:5e:00:53:1a [Link] Name=provider0

可选:重新生成

initrdRAM 磁盘镜像:# dracut -f只有在 RAM 磁盘中需要网络功能时才需要这一步。例如,如果根文件系统存储在网络设备上,如 iSCSI,则会出现这种情况。

确定哪个 NetworkManager 连接配置文件使用您要重命名的接口:

# nmcli -f device,name connection show DEVICE NAME enp1s0 example_profile ...在连接配置文件中取消

connection.interface-name属性的设置:# nmcli connection modify example_profile connection.interface-name ""临时配置连接配置文件,以匹配新的和以前的接口名称:

# nmcli connection modify example_profile match.interface-name "provider0 enp1s0"重启系统:

# reboot验证具有您在链接文件中指定的 MAC 地址的设备是否已被重命名为

provider0:# ip link show provider0: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc mq state UP mode DEFAULT group default qlen 1000 link/ether 00:00:5e:00:53:1a brd ff:ff:ff:ff:ff:ff ...配置连接配置文件,以仅匹配新接口名称:

# nmcli connection modify example_profile match.interface-name "provider0"现在,您已经从连接配置文件中删除了旧接口名称。

重新激活连接配置文件。

# nmcli connection up example_profile

其他资源

-

您系统上的

systemd.link (5)手册页

1.8. 使用 systemd 链接文件为网络接口分配替代名称

通过替代接口命名,内核可以为网络接口分配额外的名称。您可以以同样的方式将这些替代名称在需要网络接口名称的命令中用作普通的接口名称。

先决条件

- 对于替代名称,您必须使用 ASCII 字符。

- 备用名称必须小于 128 个字符。

流程

显示网络接口名称及其 MAC 地址:

# ip link show ... enp1s0: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc fq_codel state UP mode DEFAULT group default qlen 1000 link/ether 00:00:5e:00:53:1a brd ff:ff:ff:ff:ff:ff ...记录您要为其分配替代名称的接口的 MAC 地址。

如果其不存在,请创建

/etc/systemd/network/目录:# mkdir -p /etc/systemd/network/对于每个必须有备用名称的接口,在

/etc/systemd/network/目录中创建一个具有唯一名称和.link后缀的/usr/lib/systemd/network/99-default.link文件的副本,例如:# cp /usr/lib/systemd/network/99-default.link /etc/systemd/network/98-lan.link修改您在上一步中创建的文件。按如下所示重写

[Match]部分,并将AlternativeName条目附加到[Link]部分:[Match] MACAddress=<MAC_address> [Link] ... AlternativeName=<alternative_interface_name_1> AlternativeName=<alternative_interface_name_2> AlternativeName=<alternative_interface_name_n>

例如,创建具有以下内容的

/etc/systemd/network/70-altname.link文件,来将provider作为一个替代名称分配给 MAC 地址为00:00:5e:00:53:1a的接口:[Match] MACAddress=00:00:5e:00:53:1a [Link] NamePolicy=keep kernel database onboard slot path AlternativeNamesPolicy=database onboard slot path MACAddressPolicy=none AlternativeName=provider

重新生成

initrdRAM 磁盘镜像:# dracut -f重启系统:

# reboot

验证

使用替代接口名称。例如,显示替代名称为

provider的设备的 IP 地址设置:# ip address show provider 2: enp1s0: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc fq_codel state UP group default qlen 1000 link/ether 00:00:5e:00:53:1a brd ff:ff:ff:ff:ff:ff altname provider ...

其他资源

第 2 章 配置以太网连接

NetworkManager 为主机上安装的每个以太网适配器创建一个连接配置文件。默认情况下,此配置文件将 DHCP 用于 IPv4 和 IPv6 连接。修改此自动创建的配置文件,或在以下情况下添加一个新配置文件:

- 网络需要自定义设置,如静态 IP 地址配置。

- 您需要多个配置文件,因为主机在不同的网络间漫游。

Red Hat Enterprise Linux 为管理员提供不同的选项来配置以太网连接。例如:

-

在命令行中使用

nmcli配置连接。 -

使用

nmtui在基于文本的用户界面中配置连接。 -

使用 GNOME Settings 菜单或

nm-connection-editor应用程序在图形界面中配置连接。 -

使用

nmstatectl通过 Nmstate API 配置连接。 - 使用 RHEL 系统角色自动化一个或多个主机上连接的配置。

如果要对运行在 Microsoft Azure 云中的主机手动配置以太网连接,请禁用 cloud-init 服务或将其配置为忽略从云环境检索到的网络设置。否则,cloud-init 将在下次重启时覆盖您手动配置的网络设置。

2.1. 使用 nmcli 配置以太网连接

如果您通过以太网将主机连接到网络,您可以使用 nmcli 工具在命令行上管理连接的设置。

先决条件

- 服务器配置中存在物理或虚拟以太网网络接口控制器(NIC)。

流程

列出 NetworkManager 连接配置文件:

# nmcli connection show NAME UUID TYPE DEVICE Wired connection 1 a5eb6490-cc20-3668-81f8-0314a27f3f75 ethernet enp1s0默认情况下,NetworkManager 为主机中的每个 NIC 创建一个配置文件。如果您计划仅将这个 NIC 连接到特定的网络,请调整自动创建的配置文件。如果您计划将这个 NIC 连接到具有不同设置的网络,请为每个网络创建单独的配置文件。

如果要创建额外的连接配置文件,请输入:

# nmcli connection add con-name <connection-name> ifname <device-name> type ethernet跳过此步骤以修改现有配置文件。

可选:重命名连接配置文件:

# nmcli connection modify "Wired connection 1" connection.id "Internal-LAN"在具有多个配置文件的主机上,有意义的名称可以更容易识别配置文件的用途。

显示连接配置文件的当前设置:

# nmcli connection show Internal-LAN ... connection.interface-name: enp1s0 connection.autoconnect: yes ipv4.method: auto ipv6.method: auto ...配置 IPv4 设置:

要使用 DHCP,请输入:

# nmcli connection modify Internal-LAN ipv4.method auto如果

ipv4.method已设置为auto(默认),请跳过这一步。要设置静态 IPv4 地址、网络掩码、默认网关、DNS 服务器和搜索域,请输入:

# nmcli connection modify Internal-LAN ipv4.method manual ipv4.addresses 192.0.2.1/24 ipv4.gateway 192.0.2.254 ipv4.dns 192.0.2.200 ipv4.dns-search example.com

配置 IPv6 设置:

要使用无状态地址自动配置(SLAAC),请输入:

# nmcli connection modify Internal-LAN ipv6.method auto如果

ipv6.method已设置为auto(默认),请跳过这一步。要设置静态 IPv6 地址、网络掩码、默认网关、DNS 服务器和搜索域,请输入:

# nmcli connection modify Internal-LAN ipv6.method manual ipv6.addresses 2001:db8:1::fffe/64 ipv6.gateway 2001:db8:1::fffe ipv6.dns 2001:db8:1::ffbb ipv6.dns-search example.com

要在配置文件中自定义其他设置,请使用以下命令:

# nmcli connection modify <connection-name> <setting> <value>将值用空格或分号括在引号中。

激活配置文件:

# nmcli connection up Internal-LAN

验证

显示 NIC 的 IP 设置:

# ip address show enp1s0 2: enp1s0: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc fq_codel state UP group default qlen 1000 link/ether 52:54:00:17:b8:b6 brd ff:ff:ff:ff:ff:ff inet 192.0.2.1/24 brd 192.0.2.255 scope global noprefixroute enp1s0 valid_lft forever preferred_lft forever inet6 2001:db8:1::fffe/64 scope global noprefixroute valid_lft forever preferred_lft forever显示 IPv4 默认网关:

# ip route show default default via 192.0.2.254 dev enp1s0 proto static metric 102显示 IPv6 默认网关:

# ip -6 route show default default via 2001:db8:1::ffee dev enp1s0 proto static metric 102 pref medium显示 DNS 设置:

# cat /etc/resolv.conf search example.com nameserver 192.0.2.200 nameserver 2001:db8:1::ffbb如果多个连接配置文件同时处于活跃状态,则

nameserver条目的顺序取决于这些配置文件中的 DNS 优先级值和连接类型。使用

ping程序来验证这个主机是否可以向其它主机发送数据包:# ping <host-name-or-IP-address>

故障排除

- 验证网线是否插入到主机和交换机。

- 检查链路失败是否只存在于此主机上,或者也存在于其它连接到同一交换机的主机上。

- 验证网络电缆和网络接口是否如预期工作。执行硬件诊断步骤,并替换有问题的网线和网络接口卡。

- 如果磁盘中的配置与设备中的配置不匹配,则启动或重启 NetworkManager 会创建一个代表该设备的配置的内存连接。有关详情以及如何避免此问题,请参阅红帽知识库解决方案 NetworkManager 在重启 NetworkManager 服务后复制连接。

其他资源

-

您系统上的

nm-settings (5)手册页

2.2. 使用 nmcli 交互式编辑器配置以太网连接

如果您通过以太网将主机连接到网络,您可以使用 nmcli 工具在命令行上管理连接的设置。

先决条件

- 服务器配置中存在物理或虚拟以太网网络接口控制器(NIC)。

步骤

列出 NetworkManager 连接配置文件:

# nmcli connection show NAME UUID TYPE DEVICE Wired connection 1 a5eb6490-cc20-3668-81f8-0314a27f3f75 ethernet enp1s0默认情况下,NetworkManager 为主机中的每个 NIC 创建一个配置文件。如果您计划仅将这个 NIC 连接到特定的网络,请调整自动创建的配置文件。如果您计划将这个 NIC 连接到具有不同设置的网络,请为每个网络创建单独的配置文件。

以交互模式启动

nmcli:要创建额外的连接配置文件,请输入:

# nmcli connection edit type ethernet con-name "<connection-name>"要修改现有的连接配置文件,请输入:

# nmcli connection edit con-name "<connection-name>"

可选:重命名连接配置文件:

nmcli> set connection.id Internal-LAN在具有多个配置文件的主机上,有意义的名称可以更容易识别配置文件的用途。

不要使用引号来设置包含空格的 ID,以避免

nmcli将引号作为名称的一部分。例如,要将Example Connection设置为 ID,请输入set connection.id Example Connection。显示连接配置文件的当前设置:

nmcli> print ... connection.interface-name: enp1s0 connection.autoconnect: yes ipv4.method: auto ipv6.method: auto ...如果创建新连接配置文件,请设置网络接口:

nmcli> set connection.interface-name enp1s0配置 IPv4 设置:

要使用 DHCP,请输入:

nmcli> set ipv4.method auto如果

ipv4.method已设置为auto(默认),请跳过这一步。要设置静态 IPv4 地址、网络掩码、默认网关、DNS 服务器和搜索域,请输入:

nmcli> ipv4.addresses 192.0.2.1/24 Do you also want to set 'ipv4.method' to 'manual'? [yes]: yes nmcli> ipv4.gateway 192.0.2.254 nmcli> ipv4.dns 192.0.2.200 nmcli> ipv4.dns-search example.com

配置 IPv6 设置:

要使用无状态地址自动配置(SLAAC),请输入:

nmcli> set ipv6.method auto如果

ipv6.method已设置为auto(默认),请跳过这一步。要设置静态 IPv6 地址、网络掩码、默认网关、DNS 服务器和搜索域,请输入:

nmcli> ipv6.addresses 2001:db8:1::fffe/64 Do you also want to set 'ipv6.method' to 'manual'? [yes]: yes nmcli> ipv6.gateway 2001:db8:1::fffe nmcli> ipv6.dns 2001:db8:1::ffbb nmcli> ipv6.dns-search example.com

保存并激活连接:

nmcli> save persistent保留为互动模式:

nmcli> quit

验证

显示 NIC 的 IP 设置:

# ip address show enp1s0 2: enp1s0: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc fq_codel state UP group default qlen 1000 link/ether 52:54:00:17:b8:b6 brd ff:ff:ff:ff:ff:ff inet 192.0.2.1/24 brd 192.0.2.255 scope global noprefixroute enp1s0 valid_lft forever preferred_lft forever inet6 2001:db8:1::fffe/64 scope global noprefixroute valid_lft forever preferred_lft forever显示 IPv4 默认网关:

# ip route show default default via 192.0.2.254 dev enp1s0 proto static metric 102显示 IPv6 默认网关:

# ip -6 route show default default via 2001:db8:1::ffee dev enp1s0 proto static metric 102 pref medium显示 DNS 设置:

# cat /etc/resolv.conf search example.com nameserver 192.0.2.200 nameserver 2001:db8:1::ffbb如果多个连接配置文件同时处于活跃状态,则

nameserver条目的顺序取决于这些配置文件中的 DNS 优先级值和连接类型。使用

ping程序来验证这个主机是否可以向其它主机发送数据包:# ping <host-name-or-IP-address>

故障排除

- 验证网线是否插入到主机和交换机。

- 检查链路失败是否只存在于此主机上,或者也存在于其它连接到同一交换机的主机上。

- 验证网络电缆和网络接口是否如预期工作。执行硬件诊断步骤,并替换有问题的网线和网络接口卡。

- 如果磁盘中的配置与设备中的配置不匹配,则启动或重启 NetworkManager 会创建一个代表该设备的配置的内存连接。有关详情以及如何避免此问题,请参阅红帽知识库解决方案 NetworkManager 在重启 NetworkManager 服务后复制连接。

其他资源

-

您系统上的

nm-settings (5)和nmcli (1)手册页

2.3. 使用 nmtui 配置以太网连接

如果通过以太网将主机连接到网络,您可以使用 nmtui 工具在基于文本的用户界面中管理连接的设置。使用 nmtui 创建新配置文件,并在没有图形界面的主机上更新现有配置文件。

在 nmtui 中:

- 使用光标键导航。

- 选择一个按钮并按 Enter 键。

- 使用 Space 选择并清除复选框。

- 要返回上一个屏幕,请使用 ESC。

先决条件

- 服务器配置中存在物理或虚拟以太网网络接口控制器(NIC)。

流程

如果您不知道要在连接中使用的网络设备名称,显示可用的设备:

# nmcli device status DEVICE TYPE STATE CONNECTION enp1s0 ethernet unavailable -- ...启动

nmtui:# nmtui- 选择 Edit a connection,然后按 Enter。

选择是否添加一个新连接配置文件或修改现有连接配置文件:

要创建一个新配置文件:

- 按 Add。

- 从网络类型列表中选择 Ethernet,然后按 Enter 键。

- 要修改现有的配置文件,请从列表中选择配置文件,然后按 Enter。

可选:更新连接配置文件的名称。

在具有多个配置文件的主机上,有意义的名称可以更容易识别配置文件的用途。

- 如果创建新连接配置文件,请在 Device 字段中输入网络设备名称。

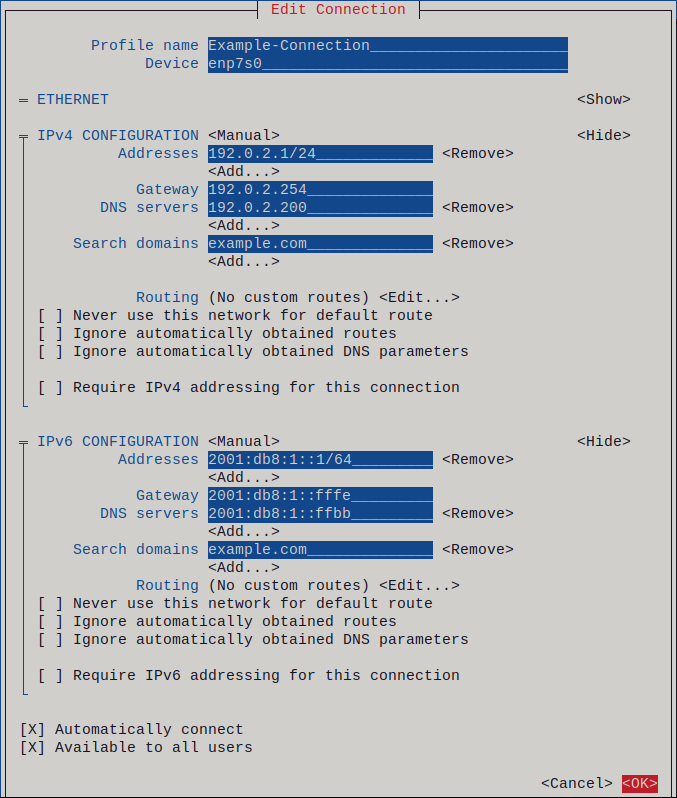

根据您的环境,相应地在

IPv4 configuration和IPv6 configuration区中配置 IP 地址。为此,请按这些区域旁边的按钮,并选择:- Disabled,如果此连接不需要 IP 地址。

- Automatic,如果 DHCP 服务器为这个 NIC 动态分配了一个 IP 地址。

Manual,如果网络需要静态 IP 地址设置。在这种情况下,您必须填写更多字段:

- 按您要配置的协议旁边的 Show 来显示其他字段。

按 Addresses 旁边的 Add,并输入无类别域间路由(CIDR)格式的 IP 地址和子网掩码。

如果没有指定子网掩码,NetworkManager 会为 IPv4 地址设置

/32子网掩码,为 IPv6 地址设置/64子网掩码。- 输入默认网关的地址。

- 按 DNS servers 旁边的 Add,并输入 DNS 服务器地址。

- 按 Search domains 旁边的 Add,并输入 DNS 搜索域。

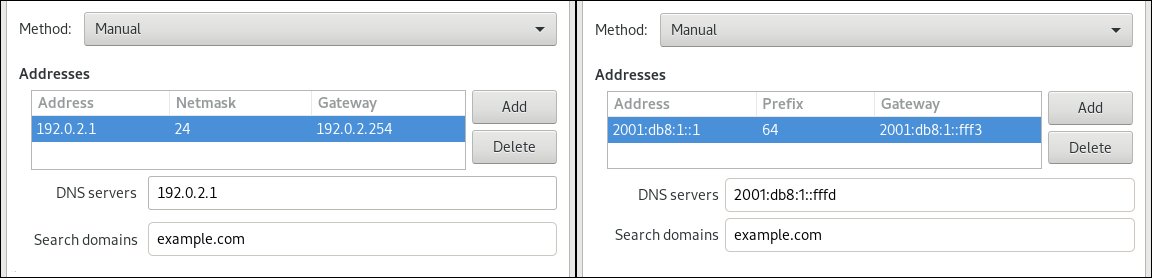

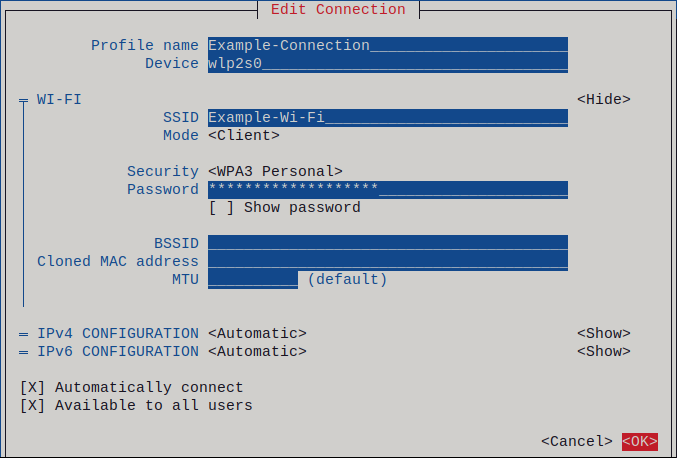

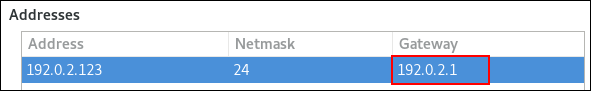

图 2.1. 具有静态 IP 地址设置的以太网连接示例

- 按 OK 创建并自动激活新连接。

- 按 Back 返回到主菜单。

-

选择 Quit,然后按 Enter 关闭

nmtui应用程序。

验证

显示 NIC 的 IP 设置:

# ip address show enp1s0 2: enp1s0: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc fq_codel state UP group default qlen 1000 link/ether 52:54:00:17:b8:b6 brd ff:ff:ff:ff:ff:ff inet 192.0.2.1/24 brd 192.0.2.255 scope global noprefixroute enp1s0 valid_lft forever preferred_lft forever inet6 2001:db8:1::fffe/64 scope global noprefixroute valid_lft forever preferred_lft forever显示 IPv4 默认网关:

# ip route show default default via 192.0.2.254 dev enp1s0 proto static metric 102显示 IPv6 默认网关:

# ip -6 route show default default via 2001:db8:1::ffee dev enp1s0 proto static metric 102 pref medium显示 DNS 设置:

# cat /etc/resolv.conf search example.com nameserver 192.0.2.200 nameserver 2001:db8:1::ffbb如果多个连接配置文件同时处于活跃状态,则

nameserver条目的顺序取决于这些配置文件中的 DNS 优先级值和连接类型。使用

ping程序来验证这个主机是否可以向其它主机发送数据包:# ping <host-name-or-IP-address>

故障排除

- 验证网线是否插入到主机和交换机。

- 检查链路失败是否只存在于此主机上,或者也存在于其它连接到同一交换机的主机上。

- 验证网络电缆和网络接口是否如预期工作。执行硬件诊断步骤,并替换有问题的网线和网络接口卡。

- 如果磁盘中的配置与设备中的配置不匹配,则启动或重启 NetworkManager 会创建一个代表该设备的配置的内存连接。有关详情以及如何避免此问题,请参阅红帽知识库解决方案 NetworkManager 在重启 NetworkManager 服务后复制连接。

2.4. 使用 control-center 配置以太网连接

如果您通过以太网将主机连接到网络,您可以使用 GNOME Settings 菜单通过图形界面管理连接的设置。

请注意,control-center 不支持与 nm-connection-editor 应用程序或 nmcli 实用程序一样多的配置选项。

先决条件

- 服务器配置中存在物理或虚拟以太网网络接口控制器(NIC)。

- 已安装了 GNOME。

步骤

-

按 Super 键,输入

Settings,然后按 Enter 键。 - 在左侧导航中选择 Network。

选择是否添加一个新连接配置文件或修改现有连接配置文件:

- 要创建一个新配置文件,请单击 Ethernet 条目旁边的 按钮。

- 要修改现有配置文件,请点击配置文件条目旁的齿轮图标。

可选:在 Identity 选项卡中,更新连接配置文件的名称。

在具有多个配置文件的主机上,有意义的名称可以更容易识别配置文件的用途。

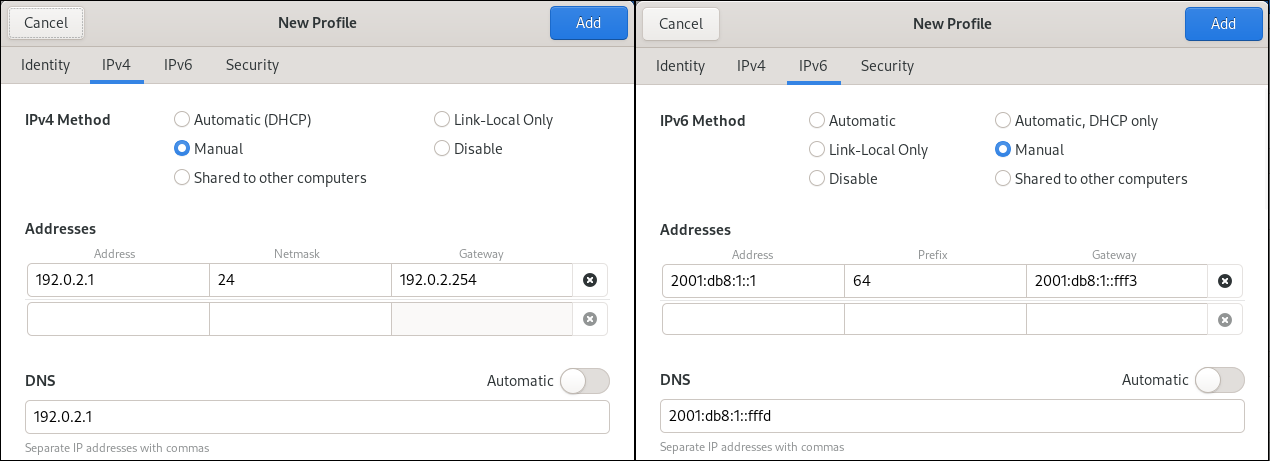

根据您的环境,相应地在 IPv4 和 IPv6 标签页中配置 IP 地址设置:

-

要使用 DHCP 或 IPv6 无状态地址自动配置(SLAAC),请选择

Automatic (DHCP)作为方法(默认)。 要设置静态 IP 地址、网络掩码、默认网关、DNS 服务器和搜索域,请选择

Manual作为方法,并在标签页中填写字段:

-

要使用 DHCP 或 IPv6 无状态地址自动配置(SLAAC),请选择

根据您是否添加或修改连接配置文件,点 或 按钮保存连接。

GNOME

control-center会自动激活连接。

验证

显示 NIC 的 IP 设置:

# ip address show enp1s0 2: enp1s0: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc fq_codel state UP group default qlen 1000 link/ether 52:54:00:17:b8:b6 brd ff:ff:ff:ff:ff:ff inet 192.0.2.1/24 brd 192.0.2.255 scope global noprefixroute enp1s0 valid_lft forever preferred_lft forever inet6 2001:db8:1::fffe/64 scope global noprefixroute valid_lft forever preferred_lft forever显示 IPv4 默认网关:

# ip route show default default via 192.0.2.254 dev enp1s0 proto static metric 102显示 IPv6 默认网关:

# ip -6 route show default default via 2001:db8:1::ffee dev enp1s0 proto static metric 102 pref medium显示 DNS 设置:

# cat /etc/resolv.conf search example.com nameserver 192.0.2.200 nameserver 2001:db8:1::ffbb如果多个连接配置文件同时处于活跃状态,则

nameserver条目的顺序取决于这些配置文件中的 DNS 优先级值和连接类型。使用

ping程序来验证这个主机是否可以向其它主机发送数据包:# ping <host-name-or-IP-address>

故障排除步骤

- 验证网线是否插入到主机和交换机。

- 检查链路失败是否只存在于此主机上,或者也存在于其它连接到同一交换机的主机上。

- 验证网络电缆和网络接口是否如预期工作。执行硬件诊断步骤,并替换有问题的网线和网络接口卡。

- 如果磁盘中的配置与设备中的配置不匹配,则启动或重启 NetworkManager 会创建一个代表该设备的配置的内存连接。有关详情以及如何避免此问题,请参阅红帽知识库解决方案 NetworkManager 在重启 NetworkManager 服务后复制连接。

2.5. 使用 nm-connection-editor 配置以太网连接

如果通过以太网将主机连接到网络,您可以使用 nm-connection-editor 应用程序使用图形界面管理连接的设置。

先决条件

- 服务器配置中存在物理或虚拟以太网网络接口控制器(NIC)。

- 已安装了 GNOME。

流程

打开终端窗口,输入:

$ nm-connection-editor选择是否添加一个新连接配置文件或修改现有连接配置文件:

要创建一个新配置文件:

- 点 按钮

- 选择 Ethernet 作为连接类型,然后单击 。

- 要修改现有配置文件,请双击配置文件条目。

可选:在 Connection Name 字段中更新配置文件的名称。

在具有多个配置文件的主机上,有意义的名称可以更容易识别配置文件的用途。

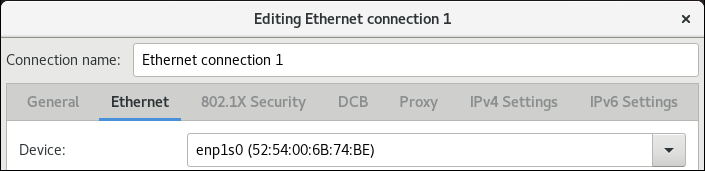

如果您创建一个新配置文件,请在

Ethernet选项卡中选择该设备:

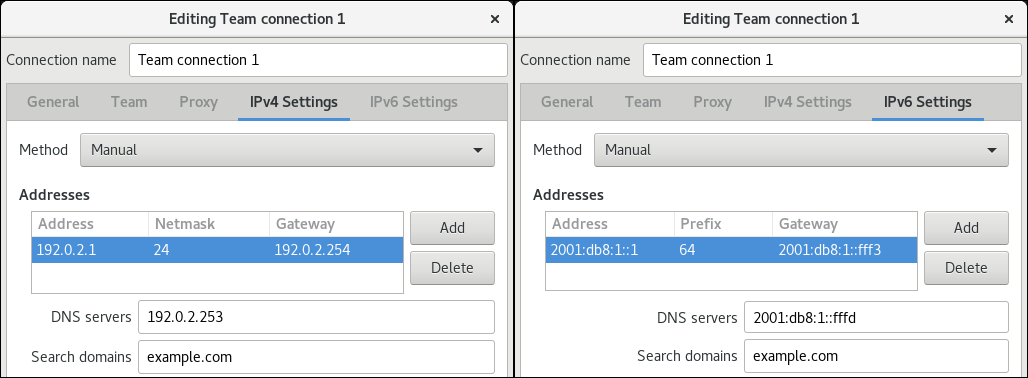

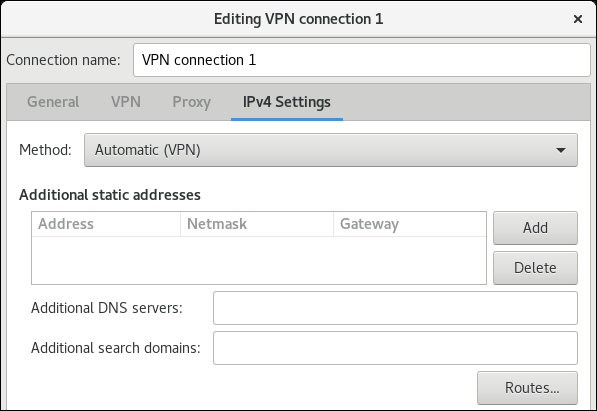

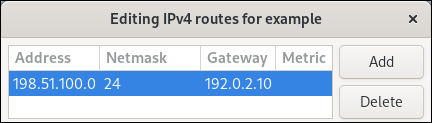

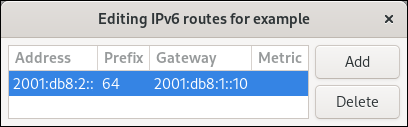

根据您的环境,相应地在 IPv4 Settings 和 IPv6 Settings 选项卡中配置 IP 地址设置:

-

要使用 DHCP 或 IPv6 无状态地址自动配置(SLAAC),请选择

Automatic (DHCP)作为方法(默认)。 要设置静态 IP 地址、网络掩码、默认网关、DNS 服务器和搜索域,请选择

Manual作为方法,并在标签页中填写字段:

-

要使用 DHCP 或 IPv6 无状态地址自动配置(SLAAC),请选择

- 点 。

- 关闭 nm-connection-editor。

验证

显示 NIC 的 IP 设置:

# ip address show enp1s0 2: enp1s0: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc fq_codel state UP group default qlen 1000 link/ether 52:54:00:17:b8:b6 brd ff:ff:ff:ff:ff:ff inet 192.0.2.1/24 brd 192.0.2.255 scope global noprefixroute enp1s0 valid_lft forever preferred_lft forever inet6 2001:db8:1::fffe/64 scope global noprefixroute valid_lft forever preferred_lft forever显示 IPv4 默认网关:

# ip route show default default via 192.0.2.254 dev enp1s0 proto static metric 102显示 IPv6 默认网关:

# ip -6 route show default default via 2001:db8:1::ffee dev enp1s0 proto static metric 102 pref medium显示 DNS 设置:

# cat /etc/resolv.conf search example.com nameserver 192.0.2.200 nameserver 2001:db8:1::ffbb如果多个连接配置文件同时处于活跃状态,则

nameserver条目的顺序取决于这些配置文件中的 DNS 优先级值和连接类型。使用

ping程序来验证这个主机是否可以向其它主机发送数据包:# ping <host-name-or-IP-address>

故障排除步骤

- 验证网线是否插入到主机和交换机。

- 检查链路失败是否只存在于此主机上,或者也存在于其它连接到同一交换机的主机上。

- 验证网络电缆和网络接口是否如预期工作。执行硬件诊断步骤,并替换有问题的网线和网络接口卡。

- 如果磁盘中的配置与设备中的配置不匹配,则启动或重启 NetworkManager 会创建一个代表该设备的配置的内存连接。有关详情以及如何避免此问题,请参阅红帽知识库解决方案 NetworkManager 在重启 NetworkManager 服务后复制连接。

2.6. 使用 nmstatectl 配置带有静态 IP 地址的以太网连接

使用 nmstatectl 工具通过 Nmstate API 配置以太网连接。Nmstate API 确保设置配置后,结果与配置文件匹配。如果有任何失败,nmstatectl 会自动回滚更改以避免系统处于不正确的状态。

先决条件

- 服务器配置中存在物理或虚拟以太网网络接口控制器(NIC)。

-

nmstate软件包已安装。

步骤

创建一个包含以下内容的 YAML 文件,如

~/create-ethernet-profile.yml:--- interfaces: - name: enp1s0 type: ethernet state: up ipv4: enabled: true address: - ip: 192.0.2.1 prefix-length: 24 dhcp: false ipv6: enabled: true address: - ip: 2001:db8:1::1 prefix-length: 64 autoconf: false dhcp: false routes: config: - destination: 0.0.0.0/0 next-hop-address: 192.0.2.254 next-hop-interface: enp1s0 - destination: ::/0 next-hop-address: 2001:db8:1::fffe next-hop-interface: enp1s0 dns-resolver: config: search: - example.com server: - 192.0.2.200 - 2001:db8:1::ffbb这些设置使用以下设置为

enp1s0设备定义一个以太网连接配置文件:-

静态 IPv4 地址 -

192.0.2.1,子网掩码为/24 -

静态 IPv6 地址 -

2001:db8:1::1,子网掩码为/64 -

IPv4 默认网关 -

192.0.2.254 -

IPv6 默认网关 -

2001:db8:1::fffe -

IPv4 DNS 服务器 -

192.0.2.200 -

IPv6 DNS 服务器 -

2001:db8:1::ffbb -

DNS 搜索域 -

example.com

-

静态 IPv4 地址 -

可选:您可以在

interfaces属性中定义identifier: mac-address和mac-address: <mac_address>属性,来通过其 MAC 地址而不是其名称来识别网络接口卡,例如:--- interfaces: - name: <profile_name> type: ethernet identifier: mac-address mac-address: <mac_address> ...

将设置应用到系统:

# nmstatectl apply ~/create-ethernet-profile.yml

验证

以 YAML 格式显示当前状态:

# nmstatectl show enp1s0显示 NIC 的 IP 设置:

# ip address show enp1s0 2: enp1s0: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc fq_codel state UP group default qlen 1000 link/ether 52:54:00:17:b8:b6 brd ff:ff:ff:ff:ff:ff inet 192.0.2.1/24 brd 192.0.2.255 scope global noprefixroute enp1s0 valid_lft forever preferred_lft forever inet6 2001:db8:1::fffe/64 scope global noprefixroute valid_lft forever preferred_lft forever显示 IPv4 默认网关:

# ip route show default default via 192.0.2.254 dev enp1s0 proto static metric 102显示 IPv6 默认网关:

# ip -6 route show default default via 2001:db8:1::ffee dev enp1s0 proto static metric 102 pref medium显示 DNS 设置:

# cat /etc/resolv.conf search example.com nameserver 192.0.2.200 nameserver 2001:db8:1::ffbb如果多个连接配置文件同时处于活跃状态,则

nameserver条目的顺序取决于这些配置文件中的 DNS 优先级值和连接类型。使用

ping程序来验证这个主机是否可以向其它主机发送数据包:# ping <host-name-or-IP-address>

其他资源

-

您系统上的

nmstatectl (8)手册页 -

/usr/share/doc/nmstate/examples/目录

2.7. 使用 network RHEL 系统角色和接口名称,配置具有静态 IP 地址的以太网连接

要将 Red Hat Enterprise Linux 主机连接到以太网网络,请为网络设备创建一个 NetworkManager 连接配置文件。通过使用 Ansible 和 network RHEL 系统角色,您可以在 playbook 中定义的主机上自动化此过程,并远程配置连接配置文件。

您可以使用 network RHEL 系统角色配置具有静态 IP 地址、网关和 DNS 设置的以太网连接,并将它们分配给指定的接口名称。

通常,管理员希望重复使用 playbook,且不会为 Ansible 应该为其分配静态 IP 地址的每个主机维护单独的 playbook。在本例中,您可以在 playbook 中使用变量,并在清单中维护设置。因此,您只需要一个 playbook 来动态地将单个设置分配给多个主机。

前提条件

- 您已准备好控制节点和受管节点

- 以可在受管主机上运行 playbook 的用户登录到控制节点。

-

用于连接到受管节点的帐户对其具有

sudo权限。 - 物理或者虚拟以太网设备在服务器配置中存在。

- 受管节点使用 NetworkManager 配置网络。

流程

编辑

~/inventory文件,并将特定于主机的设置附加到主机条目中:managed-node-01.example.com interface=enp1s0 ip_v4=192.0.2.1/24 ip_v6=2001:db8:1::1/64 gateway_v4=192.0.2.254 gateway_v6=2001:db8:1::fffe managed-node-02.example.com interface=enp1s0 ip_v4=192.0.2.2/24 ip_v6=2001:db8:1::2/64 gateway_v4=192.0.2.254 gateway_v6=2001:db8:1::fffe

创建一个包含以下内容的 playbook 文件,如

~/playbook.yml:--- - name: Configure the network hosts: managed-node-01.example.com,managed-node-02.example.com tasks: - name: Ethernet connection profile with static IP address settings ansible.builtin.include_role: name: rhel-system-roles.network vars: network_connections: - name: "{{ interface }}" interface_name: "{{ interface }}" type: ethernet autoconnect: yes ip: address: - "{{ ip_v4 }}" - "{{ ip_v6 }}" gateway4: "{{ gateway_v4 }}" gateway6: "{{ gateway_v6 }}" dns: - 192.0.2.200 - 2001:db8:1::ffbb dns_search: - example.com state: up此 playbook 从清单文件中动态读取每个主机的某些值,并在 playbook 中对所有主机的相同设置使用静态值。

有关 playbook 中使用的所有变量的详情,请查看控制节点上的

/usr/share/ansible/roles/rhel-system-roles.network/README.md文件。验证 playbook 语法:

$ ansible-playbook --syntax-check ~/playbook.yml请注意,这个命令只验证语法,不会防止错误,但保护有效配置。

运行 playbook:

$ ansible-playbook ~/playbook.yml

验证

查询受管节点的 Ansible 事实,并验证活跃的网络设置:

# ansible managed-node-01.example.com -m ansible.builtin.setup ... "ansible_default_ipv4": { "address": "192.0.2.1", "alias": "enp1s0", "broadcast": "192.0.2.255", "gateway": "192.0.2.254", "interface": "enp1s0", "macaddress": "52:54:00:17:b8:b6", "mtu": 1500, "netmask": "255.255.255.0", "network": "192.0.2.0", "prefix": "24", "type": "ether" }, "ansible_default_ipv6": { "address": "2001:db8:1::1", "gateway": "2001:db8:1::fffe", "interface": "enp1s0", "macaddress": "52:54:00:17:b8:b6", "mtu": 1500, "prefix": "64", "scope": "global", "type": "ether" }, ... "ansible_dns": { "nameservers": [ "192.0.2.1", "2001:db8:1::ffbb" ], "search": [ "example.com" ] }, ...

其他资源

-

/usr/share/ansible/roles/rhel-system-roles.network/README.md文件 -

/usr/share/doc/rhel-system-roles/network/directory

2.8. 使用 network RHEL 系统角色和设备路径,配置具有静态 IP 地址的以太网连接

要将 Red Hat Enterprise Linux 主机连接到以太网网络,请为网络设备创建一个 NetworkManager 连接配置文件。通过使用 Ansible 和 network RHEL 系统角色,您可以在 playbook 中定义的主机上自动化此过程,并远程配置连接配置文件。

您可以使用 network RHEL 系统角色配置具有静态 IP 地址、网关和 DNS 设置的以太网连接,并根据路径而不是其名称将它们分配给设备。

前提条件

- 您已准备好控制节点和受管节点

- 以可在受管主机上运行 playbook 的用户登录到控制节点。

-

用于连接到受管节点的帐户对其具有

sudo权限。 - 服务器配置中有一个物理或者虚拟以太网设备。

- 受管节点使用 NetworkManager 配置网络。

-

您知道设备的路径。您可以使用

udevadm info /sys/class/net/<device_name> | grep ID_PATH=命令显示设备路径。

流程

创建一个包含以下内容的 playbook 文件,如

~/playbook.yml:--- - name: Configure the network hosts: managed-node-01.example.com tasks: - name: Ethernet connection profile with static IP address settings ansible.builtin.include_role: name: rhel-system-roles.network vars: network_connections: - name: example match: path: - pci-0000:00:0[1-3].0 - &!pci-0000:00:02.0 type: ethernet autoconnect: yes ip: address: - 192.0.2.1/24 - 2001:db8:1::1/64 gateway4: 192.0.2.254 gateway6: 2001:db8:1::fffe dns: - 192.0.2.200 - 2001:db8:1::ffbb dns_search: - example.com state: up示例 playbook 中指定的设置包括以下内容:

match-

定义必须满足的条件,以便应用设置。您只能将此变量与

path选项一起使用。 path-

定义设备的持久路径。您可以将它设置为固定路径或表达式。其值可以包含修饰符和通配符。这个示例将设置应用到与 PCI ID

0000:00:0[1-3].0匹配,而不是与0000:00:02.0匹配的设备。

有关 playbook 中使用的所有变量的详情,请查看控制节点上的

/usr/share/ansible/roles/rhel-system-roles.network/README.md文件。验证 playbook 语法:

$ ansible-playbook --syntax-check ~/playbook.yml请注意,这个命令只验证语法,不会防止错误,但保护有效配置。

运行 playbook:

$ ansible-playbook ~/playbook.yml

验证

查询受管节点的 Ansible 事实,并验证活跃的网络设置:

# ansible managed-node-01.example.com -m ansible.builtin.setup ... "ansible_default_ipv4": { "address": "192.0.2.1", "alias": "enp1s0", "broadcast": "192.0.2.255", "gateway": "192.0.2.254", "interface": "enp1s0", "macaddress": "52:54:00:17:b8:b6", "mtu": 1500, "netmask": "255.255.255.0", "network": "192.0.2.0", "prefix": "24", "type": "ether" }, "ansible_default_ipv6": { "address": "2001:db8:1::1", "gateway": "2001:db8:1::fffe", "interface": "enp1s0", "macaddress": "52:54:00:17:b8:b6", "mtu": 1500, "prefix": "64", "scope": "global", "type": "ether" }, ... "ansible_dns": { "nameservers": [ "192.0.2.1", "2001:db8:1::ffbb" ], "search": [ "example.com" ] }, ...

其他资源

-

/usr/share/ansible/roles/rhel-system-roles.network/README.md文件 -

/usr/share/doc/rhel-system-roles/network/directory

2.9. 使用 nmstatectl 配置具有动态 IP 地址的以太网连接

使用 nmstatectl 工具通过 Nmstate API 配置以太网连接。Nmstate API 确保设置配置后,结果与配置文件匹配。如果有任何失败,nmstatectl 会自动回滚更改以避免系统处于不正确的状态。

先决条件

- 服务器配置中存在物理或虚拟以太网网络接口控制器(NIC)。

- 网络中有 DHCP 服务器。

-

nmstate软件包已安装。

步骤

创建一个包含以下内容的 YAML 文件,如

~/create-ethernet-profile.yml:--- interfaces: - name: enp1s0 type: ethernet state: up ipv4: enabled: true auto-dns: true auto-gateway: true auto-routes: true dhcp: true ipv6: enabled: true auto-dns: true auto-gateway: true auto-routes: true autoconf: true dhcp: true这些设置为

enp1s0设备定义一个以太网连接配置文件。连接从 DHCP 服务器和 IPv6 无状态地址自动配置(SLAAC)检索 IPv4 地址、IPv6 地址、默认网关、路由、DNS 服务器和搜索域。可选:您可以在

interfaces属性中定义identifier: mac-address和mac-address: <mac_address>属性,来通过其 MAC 地址而不是其名称来识别网络接口卡,例如:--- interfaces: - name: <profile_name> type: ethernet identifier: mac-address mac-address: <mac_address> ...

将设置应用到系统:

# nmstatectl apply ~/create-ethernet-profile.yml

验证

以 YAML 格式显示当前状态:

# nmstatectl show enp1s0显示 NIC 的 IP 设置:

# ip address show enp1s0 2: enp1s0: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc fq_codel state UP group default qlen 1000 link/ether 52:54:00:17:b8:b6 brd ff:ff:ff:ff:ff:ff inet 192.0.2.1/24 brd 192.0.2.255 scope global noprefixroute enp1s0 valid_lft forever preferred_lft forever inet6 2001:db8:1::fffe/64 scope global noprefixroute valid_lft forever preferred_lft forever显示 IPv4 默认网关:

# ip route show default default via 192.0.2.254 dev enp1s0 proto static metric 102显示 IPv6 默认网关:

# ip -6 route show default default via 2001:db8:1::ffee dev enp1s0 proto static metric 102 pref medium显示 DNS 设置:

# cat /etc/resolv.conf search example.com nameserver 192.0.2.200 nameserver 2001:db8:1::ffbb如果多个连接配置文件同时处于活跃状态,则

nameserver条目的顺序取决于这些配置文件中的 DNS 优先级值和连接类型。使用

ping程序来验证这个主机是否可以向其它主机发送数据包:# ping <host-name-or-IP-address>

其他资源

-

您系统上的

nmstatectl (8)手册页 -

/usr/share/doc/nmstate/examples/目录

2.10. 使用 network RHEL 系统角色和接口名称,配置具有动态 IP 地址的以太网连接

要将 Red Hat Enterprise Linux 主机连接到以太网网络,请为网络设备创建一个 NetworkManager 连接配置文件。通过使用 Ansible 和 network RHEL 系统角色,您可以在 playbook 中定义的主机上自动化此过程,并远程配置连接配置文件。

您可以使用 network RHEL 系统角色配置以太网连接,该连接从 DHCP 服务器检索其 IP 地址、网关和 DNS 设置,以及 IPv6 无状态地址自动配置(SLAAC)。使用此角色,您可以将连接配置文件分配给指定的接口名称。

前提条件

- 您已准备好控制节点和受管节点

- 以可在受管主机上运行 playbook 的用户登录到控制节点。

-

用于连接到受管节点的帐户对其具有

sudo权限。 - 物理或者虚拟以太网设备在服务器配置中存在。

- 网络中有 DHCP 服务器和 SLAAC。

- 受管节点使用 NetworkManager 服务配置网络。

流程

创建一个包含以下内容的 playbook 文件,如

~/playbook.yml:--- - name: Configure the network hosts: managed-node-01.example.com tasks: - name: Ethernet connection profile with dynamic IP address settings ansible.builtin.include_role: name: rhel-system-roles.network vars: network_connections: - name: enp1s0 interface_name: enp1s0 type: ethernet autoconnect: yes ip: dhcp4: yes auto6: yes state: up示例 playbook 中指定的设置包括以下内容:

dhcp4: yes- 启用来自 DHCP、PPP 或类似服务的自动 IPv4 地址分配。

auto6: yes-

启用 IPv6 自动配置。默认情况下,NetworkManager 使用路由器公告。如果路由器宣布

managed标记,则 NetworkManager 从 DHCPv6 服务器请求 IPv6 地址和前缀。

有关 playbook 中使用的所有变量的详情,请查看控制节点上的

/usr/share/ansible/roles/rhel-system-roles.network/README.md文件。验证 playbook 语法:

$ ansible-playbook --syntax-check ~/playbook.yml请注意,这个命令只验证语法,不会防止错误,但保护有效配置。

运行 playbook:

$ ansible-playbook ~/playbook.yml

验证

查询受管节点的 Ansible 事实,并验证接口是否收到 IP 地址和 DNS 设置:

# ansible managed-node-01.example.com -m ansible.builtin.setup ... "ansible_default_ipv4": { "address": "192.0.2.1", "alias": "enp1s0", "broadcast": "192.0.2.255", "gateway": "192.0.2.254", "interface": "enp1s0", "macaddress": "52:54:00:17:b8:b6", "mtu": 1500, "netmask": "255.255.255.0", "network": "192.0.2.0", "prefix": "24", "type": "ether" }, "ansible_default_ipv6": { "address": "2001:db8:1::1", "gateway": "2001:db8:1::fffe", "interface": "enp1s0", "macaddress": "52:54:00:17:b8:b6", "mtu": 1500, "prefix": "64", "scope": "global", "type": "ether" }, ... "ansible_dns": { "nameservers": [ "192.0.2.1", "2001:db8:1::ffbb" ], "search": [ "example.com" ] }, ...

其他资源

-

/usr/share/ansible/roles/rhel-system-roles.network/README.md文件 -

/usr/share/doc/rhel-system-roles/network/directory

2.11. 使用 network RHEL 系统角色和设备路径,配置具有动态 IP 地址的以太网连接

要将 Red Hat Enterprise Linux 主机连接到以太网网络,请为网络设备创建一个 NetworkManager 连接配置文件。通过使用 Ansible 和 network RHEL 系统角色,您可以在 playbook 中定义的主机上自动化此过程,并远程配置连接配置文件。

您可以使用 network RHEL 系统角色配置以太网连接,该连接从 DHCP 服务器检索其 IP 地址、网关和 DNS 设置,以及 IPv6 无状态地址自动配置(SLAAC)。角色可以根据其路径而不是接口名称,将连接配置文件分配给设备。

前提条件

- 您已准备好控制节点和受管节点

- 以可在受管主机上运行 playbook 的用户登录到控制节点。

-

用于连接到受管节点的帐户对其具有

sudo权限。 - 服务器配置中有一个物理或者虚拟以太网设备。

- 网络中有 DHCP 服务器和 SLAAC。

- 受管主机使用 NetworkManager 配置网络。

-

您知道设备的路径。您可以使用

udevadm info /sys/class/net/<device_name> | grep ID_PATH=命令显示设备路径。

流程

创建一个包含以下内容的 playbook 文件,如

~/playbook.yml:--- - name: Configure the network hosts: managed-node-01.example.com tasks: - name: Ethernet connection profile with dynamic IP address settings ansible.builtin.include_role: name: rhel-system-roles.network vars: network_connections: - name: example match: path: - pci-0000:00:0[1-3].0 - &!pci-0000:00:02.0 type: ethernet autoconnect: yes ip: dhcp4: yes auto6: yes state: up示例 playbook 中指定的设置包括以下内容:

match: path-

定义必须满足的条件,以便应用设置。您只能将此变量与

path选项一起使用。 path: <path_and_expressions>-

定义设备的持久路径。您可以将它设置为固定路径或表达式。其值可以包含修饰符和通配符。这个示例将设置应用到与 PCI ID

0000:00:0[1-3].0匹配,而不是与0000:00:02.0匹配的设备。 dhcp4: yes- 启用来自 DHCP、PPP 或类似服务的自动 IPv4 地址分配。

auto6: yes-

启用 IPv6 自动配置。默认情况下,NetworkManager 使用路由器公告。如果路由器宣布

managed标记,则 NetworkManager 从 DHCPv6 服务器请求 IPv6 地址和前缀。

有关 playbook 中使用的所有变量的详情,请查看控制节点上的

/usr/share/ansible/roles/rhel-system-roles.network/README.md文件。验证 playbook 语法:

$ ansible-playbook --syntax-check ~/playbook.yml请注意,这个命令只验证语法,不会防止错误,但保护有效配置。

运行 playbook:

$ ansible-playbook ~/playbook.yml

验证

查询受管节点的 Ansible 事实,并验证接口是否收到 IP 地址和 DNS 设置:

# ansible managed-node-01.example.com -m ansible.builtin.setup ... "ansible_default_ipv4": { "address": "192.0.2.1", "alias": "enp1s0", "broadcast": "192.0.2.255", "gateway": "192.0.2.254", "interface": "enp1s0", "macaddress": "52:54:00:17:b8:b6", "mtu": 1500, "netmask": "255.255.255.0", "network": "192.0.2.0", "prefix": "24", "type": "ether" }, "ansible_default_ipv6": { "address": "2001:db8:1::1", "gateway": "2001:db8:1::fffe", "interface": "enp1s0", "macaddress": "52:54:00:17:b8:b6", "mtu": 1500, "prefix": "64", "scope": "global", "type": "ether" }, ... "ansible_dns": { "nameservers": [ "192.0.2.1", "2001:db8:1::ffbb" ], "search": [ "example.com" ] }, ...

其他资源

-

/usr/share/ansible/roles/rhel-system-roles.network/README.md文件 -

/usr/share/doc/rhel-system-roles/network/directory

2.12. 按接口名称使用单个连接配置文件配置多个以太网接口

在大多数情况下,一个连接配置文件包含一个网络设备的设置。但是,当您在连接配置文件中设置接口名称时,NetworkManager 也支持通配符。如果主机在具有动态 IP 地址分配的以太网之间漫游,则您可以使用此功能创建可用于多个以太网接口的单一连接配置文件。

前提条件

- 服务器配置中存在多个物理或虚拟以太网设备。

- 网络中有 DHCP 服务器。

- 主机上不存在连接配置文件。

流程

添加可应用于以

enp开头的所有接口名称的连接配置文件:# nmcli connection add con-name "Wired connection 1" connection.multi-connect multiple match.interface-name enp* type ethernet

验证

显示单个连接配置文件的所有设置:

# nmcli connection show "Wired connection 1" connection.id: Wired connection 1 ... connection.multi-connect: 3 (multiple) match.interface-name:

enp*...3表示接口可以在特定时间被多次激活。连接配置文件使用与match.interface-name参数中的模式匹配的所有设备,因此连接配置文件具有相同的通用唯一识别符(UUID)。显示连接的状态:

# nmcli connection show NAME UUID TYPE DEVICE ... Wired connection 1 6f22402e-c0cc-49cf-b702-eaf0cd5ea7d1 ethernet enp7s0 Wired connection 1 6f22402e-c0cc-49cf-b702-eaf0cd5ea7d1 ethernet enp8s0 Wired connection 1 6f22402e-c0cc-49cf-b702-eaf0cd5ea7d1 ethernet enp9s0

其他资源

-

您系统上的

nmcli (1)手册页 -

nm-settings(5)手册页

2.13. 使用 PCI ID 为多个以太网接口配置一个连接配置文件

PCI ID 是连接到系统的设备的唯一标识符。连接配置文件根据 PCI ID 列表按匹配的接口来添加多个设备。您可以使用这个流程将多个设备 PCI ID 连接到一个连接配置文件。

先决条件

- 服务器配置中存在多个物理或虚拟以太网设备。

- 网络中有 DHCP 服务器。

- 主机上不存在连接配置文件。

流程

识别设备路径。例如,要显示以

enp开头的所有接口的设备路径,请输入:# udevadm info /sys/class/net/enp* | grep ID_PATH= ... E: ID_PATH=pci-0000:07:00.0 E: ID_PATH=pci-0000:08:00.0添加可应用于匹配

0000:00:0[7-8].0表达式的所有 PCI ID 的连接配置文件:# nmcli connection add type ethernet connection.multi-connect multiple match.path "pci-0000:07:00.0 pci-0000:08:00.0" con-name "Wired connection 1"

验证

显示连接的状态:

# nmcli connection show NAME UUID TYPE DEVICE Wired connection 1 9cee0958-512f-4203-9d3d-b57af1d88466 ethernet enp7s0 Wired connection 1 9cee0958-512f-4203-9d3d-b57af1d88466 ethernet enp8s0 ...显示连接配置集的所有设置:

# nmcli connection show "Wired connection 1" connection.id: Wired connection 1 ... connection.multi-connect: 3 (multiple) match.path: pci-0000:07:00.0,pci-0000:08:00.0 ...此连接配置文件使用 PCI ID 与

match.path参数中的模式匹配的所有设备,因此连接配置文件具有相同的全局唯一标识符(UUID)。

其他资源

-

您系统上的

nmcli (1)手册页 -

nm-settings(5)手册页

第 3 章 配置网络绑定

网络绑定是一种组合或聚合物理和虚拟网络接口的方法,以提供高吞吐量或冗余的逻辑接口。在绑定中,内核只处理所有操作。您可以在不同类型的设备中创建绑定,如以太网设备或 VLAN。

Red Hat Enterprise Linux 为管理员提供不同的选项来配置团队设备。例如:

-

使用

nmcli使用命令行配置绑定连接。 - 通过 RHEL web 控制台使用 Web 浏览器配置绑定连接。

-

使用

nmtui在基于文本的用户界面中配置绑定连接。 -

使用

nm-connection-editor应用程序在图形界面中配置绑定连接。 -

使用

nmstatectl通过 Nmstate API 配置绑定连接。 - 使用 RHEL 系统角色自动化一个或多个主机上的绑定配置。

3.1. 了解控制器和端口接口的默认行为

在使用 NetworkManager 服务管理或排除团队或绑定端口接口故障排除时,请考虑以下默认行为:

- 启动控制器接口不会自动启动端口接口。

- 启动端口接口总会启动控制器接口。

- 停止控制器接口也会停止端口接口。

- 没有端口的控制器可以启动静态 IP 连接。

- 没有端口的控制器在启动 DHCP 连接时会等待端口。

- 当您添加具有载体的端口时,等待端口且具有 DHCP 连接的控制器会完成。

- 当您添加没有载体的端口时,等待端口的具有 DHCP 连接的控制器将继续等待。

3.2. 依赖绑定模式的上游交换机配置

根据您要使用的绑定模式,您必须在交换机上配置端口:

| 绑定模式 | 交换机上的配置 |

|---|---|

|

| 需要启用静态 EtherChannel,而不是链路聚合控制协议(LACP)协商。 |

|

| 交换机上不需要任何配置。 |

|

| 需要启用静态 EtherChannel,而不是 LACP 协商。 |

|

| 需要启用静态 EtherChannel,而不是 LACP 协商。 |

|

| 需要启用 LACP 协商的 EtherChannel。 |

|

| 交换机上不需要任何配置。 |

|

| 交换机上不需要任何配置。 |

|

| 交换机上不需要任何配置。 |

有关如何配置交换机的详情,请查看交换机文档。

某些网络绑定的功能,比如故障切换机制,不支持不通过网络交换机的直接电缆连接。详情请查看红帽知识库解决方案 使用交叉网线的直接连接是否支持绑定。

3.3. 使用 nmcli 配置网络绑定

要在命令行上配置网络绑定,请使用 nmcli 工具。

先决条件

- 在服务器中安装两个或者两个以上物理或者虚拟网络设备。

-

主机在 Red Hat Enterprise Linux 9.4 或更高版本上运行。此版本引入了在此流程中使用的

port-type,controller,connection.autoconnect-ports选项。以前的 RHEL 版本使用slave-type、master和connection.autoconnect-slaves。 - 要将以太网设备用作绑定的端口,必须在服务器中安装物理或者虚拟以太网设备。

要使用 team、bridge 或 VLAN 设备作为绑定的端口,您可以在创建绑定时创建这些设备,或者预先创建它们,如:

流程

创建绑定接口:

# nmcli connection add type bond con-name bond0 ifname bond0 bond.options "mode=active-backup"这个命令会创建一个使用

active-backup模式、名为bond0的绑定。要额外设置介质独立接口(MII)监控间隔,请在

bond.options属性中添加miimon=interval选项,例如:# nmcli connection add type bond con-name bond0 ifname bond0 bond.options "mode=active-backup,miimon=1000"显示网络接口以及您要添加到绑定中的接口名称:

# nmcli device status DEVICE TYPE STATE CONNECTION enp7s0 ethernet disconnected -- enp8s0 ethernet disconnected -- bridge0 bridge connected bridge0 bridge1 bridge connected bridge1 ...在本例中:

-

没有配置

enp7s0和enp8s0。要将这些设备用作端口,请在下一步中添加连接配置集。 -

bridge0和bridge1都有现有的连接配置文件。要将这些设备用作端口,请在下一步中修改其配置集。

-

没有配置

为绑定分配接口:

如果没有配置您要分配给绑定的接口,为其创建新的连接配置集:

# nmcli connection add type ethernet port-type bond con-name bond0-port1 ifname enp7s0 controller bond0 # nmcli connection add type ethernet port-type bond con-name bond0-port2 ifname enp8s0 controller bond0

这些命令为

enp7s0和enp8s0创建配置文件,并将它们添加到bond0连接中。要将现有的连接配置文件分配给绑定:

将这些连接的

controller参数设置为bond0:# nmcli connection modify bridge0 controller bond0 # nmcli connection modify bridge1 controller bond0

这些命令将名为

bridge0和bridge1的现有连接配置文件分配给bond0连接。重新激活连接:

# nmcli connection up bridge0 # nmcli connection up bridge1

配置 IPv4 设置:

如果您计划将此绑定设备用作其它设备的端口,请输入:

# nmcli connection modify bond0 ipv4.method disabled- 要使用 DHCP,不需要进行任何操作。

要为

bond0连接设置静态 IPv4 地址、网络掩码、默认网关和 DNS 服务器设置,请输入:# nmcli connection modify bond0 ipv4.addresses '192.0.2.1/24' ipv4.gateway '192.0.2.254' ipv4.dns '192.0.2.253' ipv4.dns-search 'example.com' ipv4.method manual

配置 IPv6 设置:

如果您计划将此绑定设备用作其它设备的端口,请输入:

# nmcli connection modify bond0 ipv6.method disabled- 要使用无状态地址自动配置(SLAAC),则不需要任何操作。

要为

bond0连接设置静态 IPv6 地址、网络掩码、默认网关和 DNS 服务器设置,请输入:# nmcli connection modify bond0 ipv6.addresses '2001:db8:1::1/64' ipv6.gateway '2001:db8:1::fffe' ipv6.dns '2001:db8:1::fffd' ipv6.dns-search 'example.com' ipv6.method manual

可选:如果要对绑定端口设置任何参数,请使用以下命令:

# nmcli connection modify bond0-port1 bond-port.<parameter> <value>激活连接:

# nmcli connection up bond0验证端口是否已连接,并且

CONNECTION列是否显示端口的连接名称:# nmcli device DEVICE TYPE STATE CONNECTION ... enp7s0 ethernet connected bond0-port1 enp8s0 ethernet connected bond0-port2当您激活连接的任何端口时,NetworkManager 也激活绑定,但不会激活它的其它端口。您可以配置 Red Hat Enterprise Linux 在启用绑定时自动启用所有端口:

启用绑定连接的

connection.autoconnect-ports参数:# nmcli connection modify bond0 connection.autoconnect-ports 1重新激活桥接:

# nmcli connection up bond0

验证

从其中一个网络设备中临时删除网线,并检查绑定中的其他设备是否在处理流量。

请注意,无法使用软件工具正确测试链路失败事件。停用连接的工具(如

nmcli),只显示绑定驱动程序可以处理端口配置的更改,而不是实际的链接失败事件。显示绑定状态:

# cat /proc/net/bonding/bond0

3.4. 使用 RHEL web 控制台配置网络绑定

如果您希望使用基于 Web 浏览器的界面管理网络设置,请使用 RHEL web 控制台配置网络绑定。

先决条件

- 在服务器中安装两个或者两个以上物理或者虚拟网络设备。

- 要将以太网设备用作绑定的成员,必须在服务器中安装物理或者虚拟以太网设备。

要将 team、bridge 或 VLAN 设备用作绑定成员,请预先创建它们,如:

- 您已安装了 RHEL 9 web 控制台。

- 您已启用了 cockpit 服务。

您的用户帐户被允许登录到 web 控制台。

具体步骤请参阅安装并启用 Web 控制台。

流程

登录到 RHEL 9 web 控制台。

详情请参阅 登录到 web 控制台。

- 在屏幕左侧的导航中选择 Networking 选项卡。

- 在 Interfaces 部分点 。

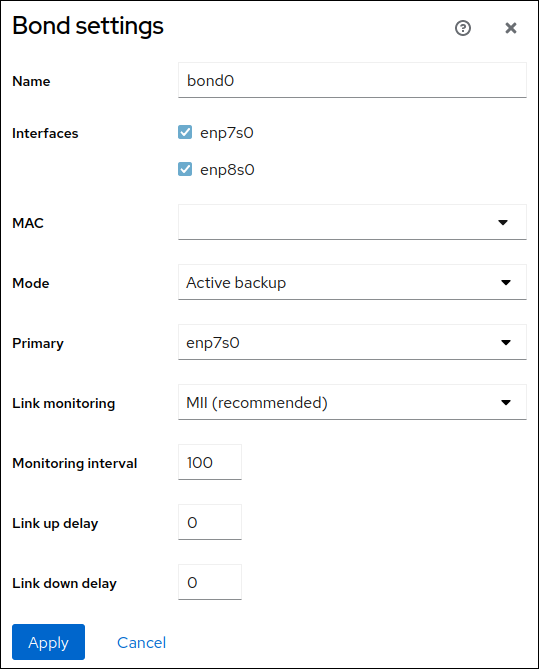

- 输入您要创建的绑定设备名称。

- 选择应该是绑定成员的接口。

选择绑定模式。

如果您选择 Active backup,Web 控制台会显示额外的 Primary 字段,您可以在其中选择首选的活动设备。

-

设置链路监控模式。例如,当您使用 Adaptive 负载均衡 模式时,将它设置为

ARP。 可选:调整监控间隔、链接延迟和连接延迟设置。通常,您只需要更改默认值以进行故障排除。

- 点。

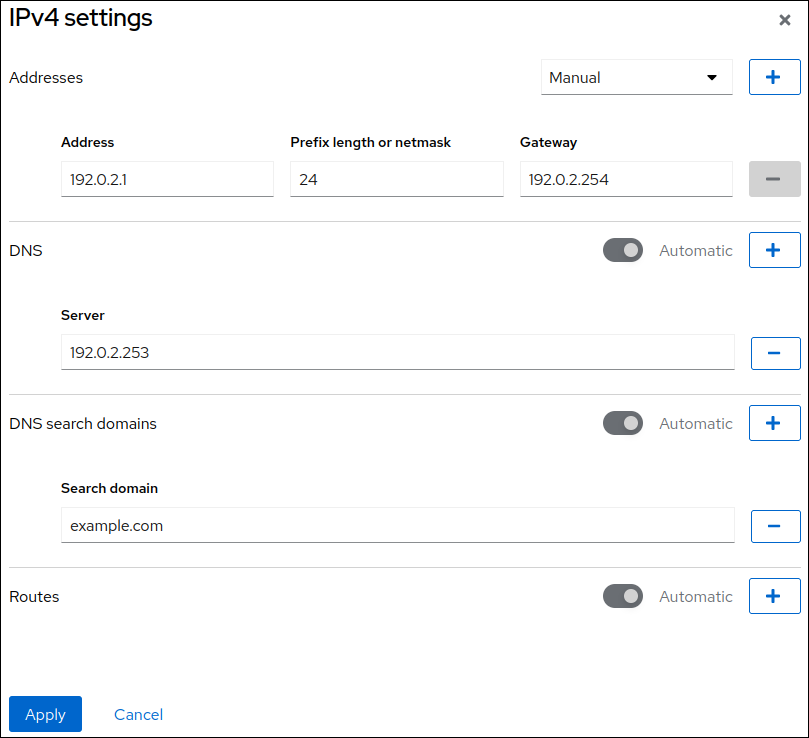

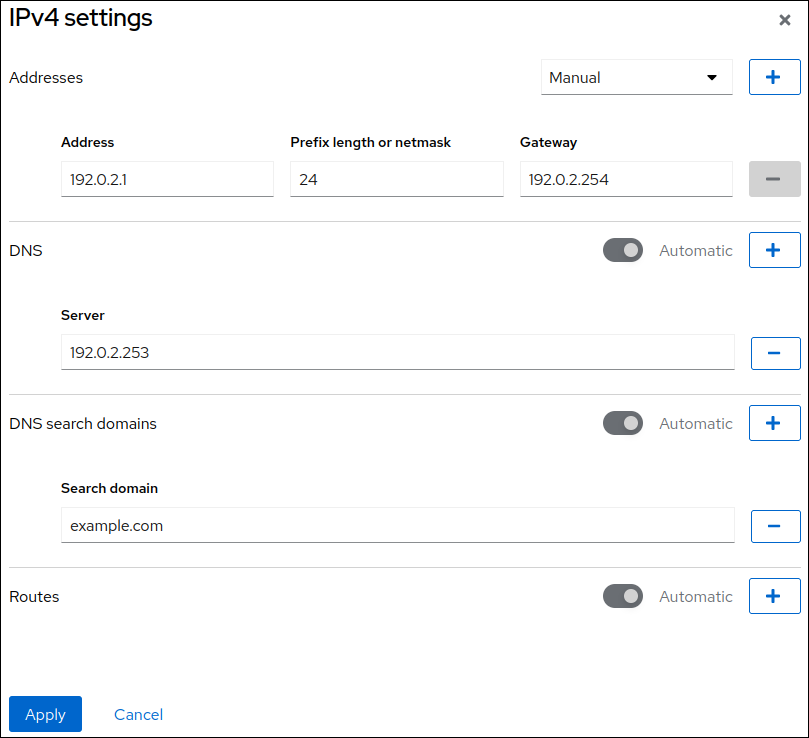

默认情况下,绑定使用动态 IP 地址。如果要设置静态 IP 地址:

- 在 Interfaces 部分点绑定的名称。

- 点您要配置的协议旁的 Edit。

- 选择 Addresses 旁的 Manual,并输入 IP 地址、前缀和默认网关。

- 在 DNS 部分,点 按钮,并输入 DNS 服务器的 IP 地址。重复此步骤来设置多个 DNS 服务器。

- 在 DNS search domains 部分中,点 按钮并输入搜索域。

如果接口需要静态路由,请在 Routes 部分配置它们。

- 点

验证

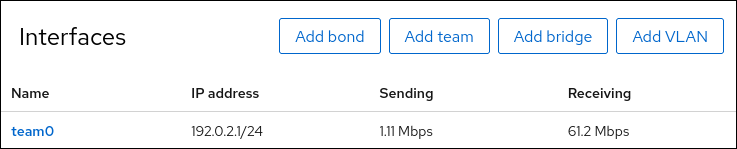

在屏幕左侧的导航中选择 Networking 选项卡,并检查接口上是否有传入和传出流量:

从其中一个网络设备中临时删除网线,并检查绑定中的其他设备是否在处理流量。

请注意,无法使用软件工具正确测试链路失败事件。取消激活连接的工具(如 Web 控制台)只显示处理成员配置更改且没有实际链路失败事件的能力。

显示绑定状态:

# cat /proc/net/bonding/bond0

3.5. 使用 nmtui 配置网络绑定

nmtui 应用程序为 NetworkManager 提供了一个基于文本的用户界面。您可以使用 nmtui 在没有图形界面的主机上配置网络绑定。

在 nmtui 中:

- 使用光标键导航。

- 选择一个按钮并按 Enter 键。

- 使用 Space 选择并清除复选框。

- 要返回上一个屏幕,请使用 ESC。

先决条件

- 在服务器中安装两个或者两个以上物理或者虚拟网络设备。

- 要将以太网设备用作绑定的端口,必须在服务器中安装物理或者虚拟以太网设备。

流程

如果您不知道您要在其上配置网络绑定的网络设备名称,请显示可用的设备:

# nmcli device status DEVICE TYPE STATE CONNECTION enp7s0 ethernet unavailable -- enp8s0 ethernet unavailable -- ...启动

nmtui:# nmtui- 选择 Edit a connection,然后按 Enter。

- 按 Add。

- 从网络类型列表中选择 Bond,然后按 Enter 键。

可选:为要创建的 NetworkManager 配置文件输入一个名称。

在具有多个配置文件的主机上,有意义的名称可以更容易识别配置文件的用途。

- 在 Device 字段中输入要创建的绑定设备的名称。

为要创建的绑定添加端口:

- 按 Slaves 列表旁边的 Add。

- 选择您要作为端口添加到绑定的接口类型,例如 Ethernet。

- 可选:为这个绑定端口输入要创建的 NetworkManager 配置文件的名称。

- 在 Device 字段中输入端口的设备名称。

按 OK 返回到绑定设置的窗口。

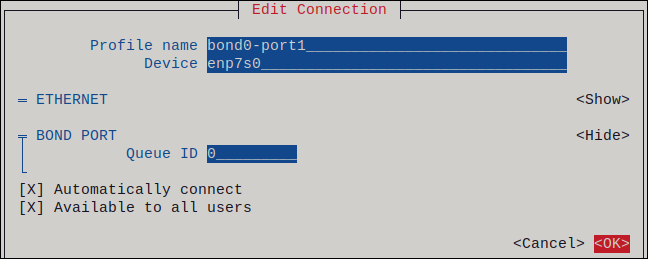

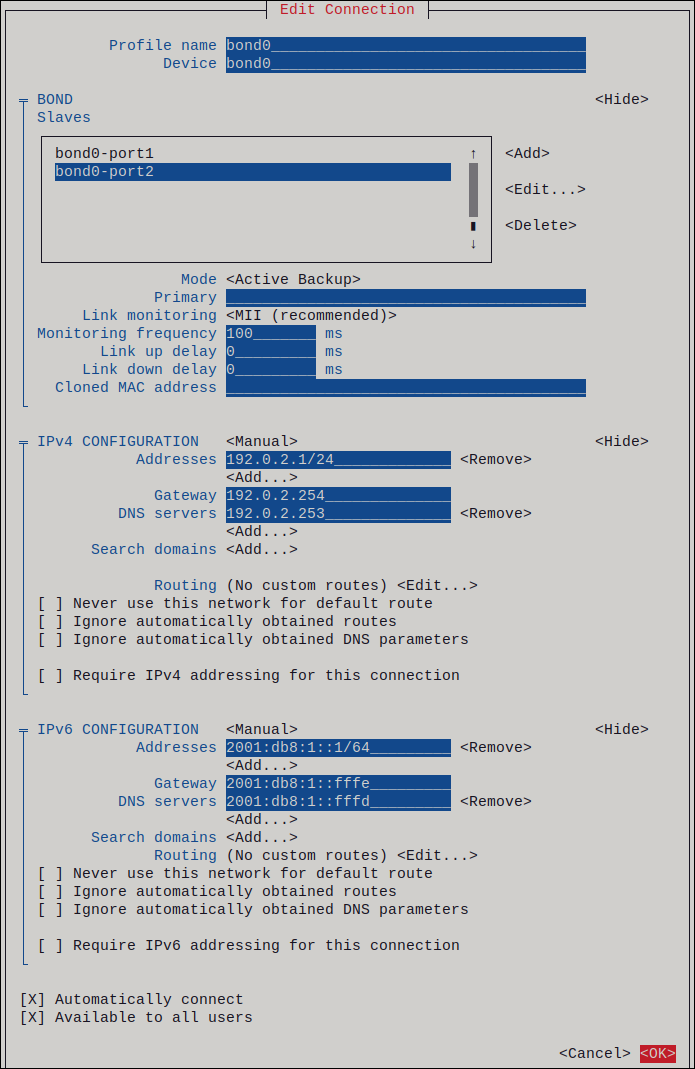

图 3.1. 将以太网设备作为端口添加到绑定

- 重复这些步骤,来向绑定添加更多的端口。

-

设置绑定模式。根据您设置的值,

nmtui会显示与所选模式相关的设置的额外字段。 根据您的环境,在 IPv4 configuration 和 IPv6 configuration 区域中相应地配置 IP 地址设置。为此,请按这些区域旁边的按钮,并选择:

-

Disabled,如果绑定不需要 IP 地址。 -

Automatic,如果 DHCP 服务器或无状态地址自动配置(SLAAC)动态为绑定分配一个 IP 地址。 Manual,如果网络需要静态 IP 地址设置。在这种情况下,您必须填写更多字段:- 按您要配置的协议旁边的 Show 来显示其他字段。

按 Addresses 旁边的 Add,并输入无类别域间路由(CIDR)格式的 IP 地址和子网掩码。

如果没有指定子网掩码,NetworkManager 会为 IPv4 地址设置

/32子网掩码,为 IPv6 地址设置/64子网掩码。- 输入默认网关的地址。

- 按 DNS servers 旁边的 Add,并输入 DNS 服务器地址。

- 按 Search domains 旁边的 Add,并输入 DNS 搜索域。

图 3.2. 具有静态 IP 地址设置的绑定连接的示例

-

- 按 OK 创建并自动激活新连接。

- 按 Back 返回到主菜单。

-

选择 Quit,然后按 Enter 关闭

nmtui应用程序。

验证

从其中一个网络设备中临时删除网线,并检查绑定中的其他设备是否在处理流量。

请注意,无法使用软件工具正确测试链路失败事件。停用连接的工具(如

nmcli),只显示绑定驱动程序可以处理端口配置的更改,而不是实际的链接失败事件。显示绑定状态:

# cat /proc/net/bonding/bond0

3.6. 使用 nm-connection-editor 配置网络绑定

如果使用带有图形界面的 Red Hat Enterprise Linux ,您可以使用 nm-connection-editor 应用程序配置网络绑定。

请注意:nm-connection-editor 只能向绑定添加新端口。要使用现有连接配置文件作为端口,请使用 nmcli 工具创建绑定,如 使用 nmcli 配置网络绑定 中所述。

先决条件

- 在服务器中安装两个或者两个以上物理或者虚拟网络设备。

- 要将以太网设备用作绑定的端口,必须在服务器中安装物理或者虚拟以太网设备。

- 要使用 team、bond 或 VLAN 设备作为绑定的端口,请确保这些设备还没有配置。

流程

打开一个终端,输入

nm-connection-editor:$ nm-connection-editor- 点击 按钮来添加一个新的连接。

- 选择 Bond 连接类型,然后单击 。

在 Bond 选项卡中:

- 可选:在 Interface name 字段中设置绑定接口的名称。

点 按钮将网络接口作为端口添加到绑定。

- 选择接口的连接类型。例如,为有线连接选择 Ethernet。

- 可选:为端口设置连接名称。

- 如果您为以太网设备创建了一个连接配置文件,请打开 Ethernet 选项卡,在 Device 字段中选择您要作为端口添加到绑定的网络接口。如果您选择了不同的设备类型,请相应地进行配置。请注意,您只能在没有配置的绑定中使用以太网接口。

- 点 。

对您要添加到绑定的每个接口重复前面的步骤:

- 可选:设置其他选项,如介质独立接口(MII)监控间隔。

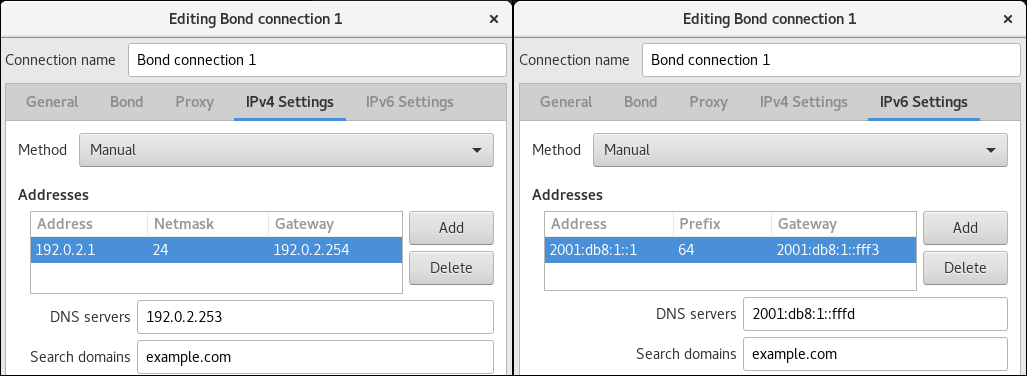

在 IPv4 Settings 和 IPv6 Settings 标签页中配置 IP 地址设置:

- 如果您计划将此网桥设备用作其它设备的端口,请将 Method 字段设置为 Disabled。

- 要使用 DHCP,请将 Method 字段保留为默认值 Automatic (DHCP)。

要使用静态 IP 设置,请将 Method 字段设置为 Manual,并相应地填写字段:

- 点 。

-

关闭

nm-connection-editor。

验证

从其中一个网络设备中临时删除网线,并检查绑定中的其他设备是否在处理流量。

请注意,无法使用软件工具正确测试链路失败事件。停用连接的工具(如

nmcli),只显示绑定驱动程序可以处理端口配置的更改,而不是实际的链接失败事件。显示绑定状态:

# cat /proc/net/bonding/bond0

3.7. 使用 nmstatectl 配置网络绑定

使用 nmstatectl 工具通过 Nmstate API 配置网络绑定。Nmstate API 确保设置配置后,结果与配置文件匹配。如果有任何失败,nmstatectl 会自动回滚更改以避免系统处于不正确的状态。

根据您的环境,相应地调整 YAML 文件。例如,要在绑定中使用与以太网适配器不同的设备,请调整您在绑定中使用的端口的 base-iface 属性和 type 属性。

先决条件

- 在服务器中安装两个或者两个以上物理或者虚拟网络设备。

- 要将以太网设备用作绑定中的端口,必须在服务器中安装物理或者虚拟以太网设备。

-

要在绑定中使用团队、网桥或 VLAN 设备作为端口,请在

port列表中设置接口名称,并定义相应的接口。 -

nmstate软件包已安装。

流程

创建包含一个以下内容的 YAML 文件,如

~/create-bond.yml:--- interfaces: - name: bond0 type: bond state: up ipv4: enabled: true address: - ip: 192.0.2.1 prefix-length: 24 dhcp: false ipv6: enabled: true address: - ip: 2001:db8:1::1 prefix-length: 64 autoconf: false dhcp: false link-aggregation: mode: active-backup port: - enp1s0 - enp7s0 - name: enp1s0 type: ethernet state: up - name: enp7s0 type: ethernet state: up routes: config: - destination: 0.0.0.0/0 next-hop-address: 192.0.2.254 next-hop-interface: bond0 - destination: ::/0 next-hop-address: 2001:db8:1::fffe next-hop-interface: bond0 dns-resolver: config: search: - example.com server: - 192.0.2.200 - 2001:db8:1::ffbb这些设置使用以下设置定义网络绑定:

-

绑定中的网络接口:

enp1s0和enp7s0 -

模式:

active-backup -

静态 IPv4 地址:

192.0.2.1,子网掩码为/24 -

静态 IPv6 地址:

2001:db8:1::1子网掩码为/64 -

IPv4 默认网关:

192.0.2.254 -

IPv6 默认网关:

2001:db8:1::fffe -

IPv4 DNS 服务器:

192.0.2.200 -

IPv6 DNS 服务器:

2001:db8:1::ffbb -

DNS 搜索域:

example.com

-

绑定中的网络接口:

将设置应用到系统:

# nmstatectl apply ~/create-bond.yml

验证

显示设备和连接的状态:

# nmcli device status DEVICE TYPE STATE CONNECTION bond0 bond connected bond0

显示连接配置集的所有设置:

# nmcli connection show bond0 connection.id: bond0 connection.uuid: 79cbc3bd-302e-4b1f-ad89-f12533b818ee connection.stable-id: -- connection.type: bond connection.interface-name: bond0 ...以 YAML 格式显示连接设置:

# nmstatectl show bond0

其他资源

-

您系统上的

nmstatectl (8)手册页 -

/usr/share/doc/nmstate/examples/目录

3.8. 使用 network RHEL 系统角色配置网络绑定

您可以将网络接口组合到绑定中,来提供具有高吞吐量或冗余的逻辑接口。要配置绑定,请创建一个 NetworkManager 连接配置文件。通过使用 Ansible 和 network RHEL 系统角色,您可以在 playbook 中定义的主机上自动化此过程,并远程配置连接配置文件。

您可以使用 network RHEL 系统角色配置网络绑定,如果绑定的父设备的连接配置文件不存在,角色也可以创建它。

前提条件

- 您已准备好控制节点和受管节点

- 以可在受管主机上运行 playbook 的用户登录到控制节点。

-

用于连接到受管节点的帐户对其具有

sudo权限。 - 在服务器中安装两个或者两个以上物理或者虚拟网络设备。

流程

创建一个包含以下内容的 playbook 文件,如

~/playbook.yml:--- - name: Configure the network hosts: managed-node-01.example.com tasks: - name: Bond connection profile with two Ethernet ports ansible.builtin.include_role: name: rhel-system-roles.network vars: network_connections: # Bond profile - name: bond0 type: bond interface_name: bond0 ip: dhcp4: yes auto6: yes bond: mode: active-backup state: up # Port profile for the 1st Ethernet device - name: bond0-port1 interface_name: enp7s0 type: ethernet controller: bond0 state: up # Port profile for the 2nd Ethernet device - name: bond0-port2 interface_name: enp8s0 type: ethernet controller: bond0 state: up示例 playbook 中指定的设置包括以下内容:

type: <profile_type>- 设置要创建的配置文件的类型。示例 playbook 创建三个连接配置文件:一个用于绑定,两个用于以太网设备。

dhcp4: yes- 启用来自 DHCP、PPP 或类似服务的自动 IPv4 地址分配。

auto6: yes-

启用 IPv6 自动配置。默认情况下,NetworkManager 使用路由器公告。如果路由器宣布

managed标记,则 NetworkManager 从 DHCPv6 服务器请求 IPv6 地址和前缀。 mode: <bond_mode>设置绑定模式。可能的值有:

-

balance-rr(默认) -

active-backup -

balance-xor -

broadcast -

802.3ad -

balance-tlb -

balance-alb。

根据您设置的模式,您需要在 playbook 中设置额外的变量。

-

有关 playbook 中使用的所有变量的详情,请查看控制节点上的

/usr/share/ansible/roles/rhel-system-roles.network/README.md文件。验证 playbook 语法:

$ ansible-playbook --syntax-check ~/playbook.yml请注意,这个命令只验证语法,不会防止错误,但保护有效配置。

运行 playbook:

$ ansible-playbook ~/playbook.yml

验证

从其中一个网络设备中临时删除网线,并检查绑定中的其他设备是否在处理流量。

请注意,无法使用软件工具正确测试链路失败事件。停用连接的工具(如

nmcli),只显示绑定驱动程序可以处理端口配置的更改,而不是实际的链接失败事件。

其他资源

-

/usr/share/ansible/roles/rhel-system-roles.network/README.md文件 -

/usr/share/doc/rhel-system-roles/network/directory

3.9. 创建网络绑定以便在不中断 VPN 的情况下在以太网和无线连接间进行切换

将工作站连接到公司网络的 RHEL 用户通常会使用 VPN 访问远程资源。然而,如果工作站在以太网和 Wi-Fi 连接间切换,例如:如果您是从带以太网连接的 docking 站中释放的笔记本电脑,VPN 连接就中断。要避免这个问题,您可以在 active-backup 模式中创建使用以太网和 Wi-Fi 连接的网络绑定。

先决条件

- 主机包含以太网和 Wi-Fi 设备。

已创建以太网和 Wi-Fi 网络管理器连接配置集,且两个连接都可以独立工作。

此流程使用以下连接配置文件来创建名为

bond0的网络绑定:-

与

enp11s0u1以太网设备关联的Docking_station -

Wi-Fi与wlp1s0Wi-Fi 设备关联

-

与

流程

在

active-backup模式中创建一个绑定接口:# nmcli connection add type bond con-name bond0 ifname bond0 bond.options "mode=active-backup"这个命令将接口和连接配置文件命名为

bond0。配置绑定的 IPv4 设置:

- 如果您的网络中的 DHCP 服务器为主机分配 IPv4 地址,则不需要任何操作。

如果您的本地网络需要静态 IPv4 地址,请将地址、网络掩码、默认网关、DNS 服务器和 DNS 搜索域设为

bond0连接:# nmcli connection modify bond0 ipv4.addresses '192.0.2.1/24' # nmcli connection modify bond0 ipv4.gateway '192.0.2.254' # nmcli connection modify bond0 ipv4.dns '192.0.2.253' # nmcli connection modify bond0 ipv4.dns-search 'example.com' # nmcli connection modify bond0 ipv4.method manual

配置绑定的 IPv6 设置:

- 如果您的网络中的路由器或者 DHCP 服务器为主机分配 IPv6 地址,则不需要任何操作。

如果您的本地网络需要静态 IPv6 地址,请将地址、网络掩码、默认网关、DNS 服务器和 DNS 搜索域设为

bond0连接:# nmcli connection modify bond0 ipv6.addresses '2001:db8:1::1/64' # nmcli connection modify bond0 ipv6.gateway '2001:db8:1::fffe' # nmcli connection modify bond0 ipv6.dns '2001:db8:1::fffd' # nmcli connection modify bond0 ipv6.dns-search 'example.com' # nmcli connection modify bond0 ipv6.method manual

显示连接配置集:

# nmcli connection show NAME UUID TYPE DEVICE Docking_station 256dd073-fecc-339d-91ae-9834a00407f9 ethernet enp11s0u1 Wi-Fi 1f1531c7-8737-4c60-91af-2d21164417e8 wifi wlp1s0 ...下一步需要连接配置集的名称和以太网设备名称。

为绑定分配以太网连接的配置:

# nmcli connection modify Docking_station controller bond0为绑定分配 Wi-Fi 连接的连接配置集:

# nmcli connection modify Wi-Fi controller bond0如果您的 Wi-Fi 网络使用 MAC 过滤来只允许列表中的 MAC 地址访问网络,请配置 NetworkManager 将活跃端口的 MAC 地址动态分配给绑定:

# nmcli connection modify bond0 +bond.options fail_over_mac=1使用这个设置时,您必须将 Wi-Fi 设备的 MAC 地址设置为 allow 列表,而不是以太网和 Wi-Fi 设备的 MAC 地址。

将与以太连接关联的设备设置为绑定的主设备:

# nmcli con modify bond0 +bond.options "primary=enp11s0u1"使用这个设置时,如果可用,绑定总是使用以太网连接。

配置当

bond0设备激活时,NetworkManager 会自动激活端口:# nmcli connection modify bond0 connection.autoconnect-ports 1激活

bond0连接:# nmcli connection up bond0

验证

显示当前激活的设备,绑定及其端口的状态:

# cat /proc/net/bonding/bond0 Ethernet Channel Bonding Driver: v3.7.1 (April 27, 2011) Bonding Mode: fault-tolerance (active-backup) (fail_over_mac active) Primary Slave: enp11s0u1 (primary_reselect always) Currently Active Slave: enp11s0u1 MII Status: up MII Polling Interval (ms): 1 Up Delay (ms): 0 Down Delay (ms): 0 Peer Notification Delay (ms): 0 Slave Interface: enp11s0u1 MII Status: up Speed: 1000 Mbps Duplex: full Link Failure Count: 0 Permanent HW addr: 00:53:00:59:da:b7 Slave queue ID: 0 Slave Interface: wlp1s0 MII Status: up Speed: Unknown Duplex: Unknown Link Failure Count: 2 Permanent HW addr: 00:53:00:b3:22:ba Slave queue ID: 0

其它资源

3.10. 不同的网络绑定模式

Linux 绑定驱动程序提供链路聚合。绑定是并行封装多个网络接口的过程,以提供单个逻辑绑定接口。绑定接口的操作取决于也称为模式的绑定策略。不同的模式提供负载均衡或热待机服务。

Linux 绑定驱动程序支持以下模式:

- Balance-rr (Mode 0)

balance-rr使用循环算法,它按顺序将数据包从第一个可用端口传输到最后一个端口。这个模式提供负载平衡和容错。这个模式需要切换端口聚合组(也称为 EtherChannel 或类似的端口分组)。EtherChannel 是一个端口链路聚合技术,用于将多个物理以太网链接分组到一个逻辑以太网链接中。

这个模式的缺陷在于它不适用于大量工作负载,以及 TCP 吞吐量或排序数据包交付非常重要。

- Active-backup (Mode 1)

Active-backup使用策略来确定在绑定中只有一个端口活跃。这个模式提供容错功能,不需要任何交换机配置。如果活动端口失败,则备用端口将变为活动状态。绑定会向网络发送大量地址解析协议 (ARP) 响应。gratuitous ARP 强制执行 ARP 帧的接收器,以更新它们的转发表。

Active-backup模式传输一个 gratuitous ARP,宣布为主机维护连接的新路径。primary选项定义绑定接口的首选端口。- Balance-xor (Mode 2)

balance-xor使用所选传输哈希策略来发送数据包。这个模式提供负载平衡、容错和需要切换配置来设置 Etherchannel 或类似的端口分组。要改变数据包传输和平衡传输,此模式使用

xmit_hash_policy选项。根据接口上流量的源或目的地,接口需要额外的负载均衡配置。请参阅 xmit_hash_policy bonding 参数。- Broadcast (Mode 3)

广播使用在所有接口上传输每个数据包的策略。这个模式提供容错,需要交换机配置来设置 EtherChannel 或类似的端口分组。这个模式的缺陷在于它不适用于大量工作负载,以及 TCP 吞吐量或排序数据包交付非常重要。

- 802.3ad (Mode 4)

802.3ad使用同名的 IEEE 标准动态链路聚合策略。此模式提供容错功能。这个模式需要切换配置来设置链路聚合控制协议 (LACP) 端口分组。这个模式会创建聚合组,它们共享相同的速度和双工设置,并使用活跃聚合器中的所有端口。根据接口上流量的源或目的地,此模式需要额外的负载平衡配置。

默认情况下,传出流量的端口选择取决于传输哈希策略。使用传输哈希策略的

xmit_hash_policy选项更改端口选择和平衡传输。802.3ad和Balance-xor之间的差别是合规性。802.3ad策略在端口聚合组之间协商 LACP。请参阅 xmit_hash_policy bonding 参数- Balance-tlb (Mode 5)

balance-tlb使用传输负载均衡策略。这个模式提供容错、负载均衡和建立不需要任何交换机支持的频道绑定。活动端口接收传入流量。如果活动端口失败,另一个则是接管故障端口的 MAC 地址。要确定哪个接口处理传出流量,请使用以下模式之一:

-

值

0:使用哈希分发策略在不进行负载均衡的情况下分发流量 值

1:利用负载均衡将流量分配到每个端口使用 bonding 选项

tlb_dynamic_lb=0,此绑定模式使用xmit_hash_policybonding 选项来均衡传输。primary选项定义绑定接口的首选端口。

-

值

- Balance-alb (Mode 6)

balance-alb使用自适应负载平衡策略。这个模式提供容错、负载平衡,且不需要任何特殊交换机支持。这个模式包括 balance-transmit 负载均衡(

balance-tlb)和用于 IPv4 和 IPv6 流量的 receive-load 均衡。绑定会截获本地系统发送的 ARP 回复,并覆盖绑定中某个端口的源硬件地址。ARP 协商管理接收负载平衡。因此,不同的端口为服务器使用不同的硬件地址。primary选项定义绑定接口的首选端口。使用 bonding 选项tlb_dynamic_lb=0,此绑定模式使用xmit_hash_policybonding 选项来均衡传输。请参阅 xmit_hash_policy bonding 参数。

另外,您可以使用 NetworkManager 来配置以下模式:

- Balance-slb

源负载均衡(SLB)绑定模式根据流量和 VLAN 哈希的源地址在多个网络接口间分发传出的数据流。这个模式不需要任何交换机配置。

NetworkManager 使用

balance-xor模式结合nftables规则来提供 SLB。有关配置此模式的详情,请参考 使用源负载均衡在 RHEL 上配置网络绑定。

其他资源

-

/usr/share/doc/kernel-doc-<version>/Documentation/networking/bonding.rst由kernel-doc软件包提供 -

/usr/share/doc/kernel-doc-<version>/Documentation/networking/bonding.txt由kernel-doc软件包提供 - 与虚拟机客户机或容器连接的网桥一起使用的绑定模式(红帽知识库)

- How are the values for different policies in "xmit_hash_policy" bonding parameter calculated?(红帽知识库)

3.11. xmit_hash_policy bonding 参数

xmit_hash_policy 负载均衡参数在 balance-xor、802.3ad、balance-alb 和 balance-tlb 模式中选择节点选择的传输散列策略。如果 tlb_dynamic_lb 参数为 0,则只适用于模式 5 和 6。此参数可能的值是 layer2, layer2+3, layer3+4, encap2+3, encap3+4, 和 vlan+srcmac。

详情请查看表:

| 策略或网络层 | Layer2 | Layer2+3 | Layer3+4 | encap2+3 | encap3+4 | VLAN+srcmac |

| 使用 | 源和目的地 MAC 地址和以太网协议类型的 XOR | 源和目标 MAC 地址和 IP 地址的 XOR | 源和目标端口和 IP 地址的 XOR |

支持的隧道内的目的地 MAC 地址和 IP 地址的 XOR,如虚拟可扩展局域网 (VXLAN)。此模式依赖于 |

受支持的隧道内的目标端口和 IP 地址的 XOR,如 VXLAN。此模式依赖于 | VLAN ID 和源 MAC 厂商和源 MAC 设备的 XOR |

| 流量放置 | 在同一个底层网络接口上到特定网络对等的所有流量 | 同一底层网络接口上特定 IP 地址的所有流量 | 同一底层网络接口上特定 IP 地址和端口的所有流量 | |||

| 主要选择 | 如果网络流量在同一广播域中的这个系统和多个其他系统之间 | 如果此系统和多个其他系统间的网络流量会通过默认网关 | 如果此系统和其他系统之间的网络流量使用相同的 IP 地址,但会经历多个端口 | 封装的流量在源系统和多个其它系统中使用多个 IP 地址 | 封装的流量是源系统和其它使用多个端口号的系统间 | 如果绑定承载来自多个容器或虚拟机 (VM) 的网络流量,它会将其 MAC 地址直接公开给外部网络,如桥接网络,您无法配置模式 2 或模式 4 的交换机。 |

| 辅助选择 | 如果网络流量主要是此系统和默认网关后面的多个其他系统之间 | 如果网络流量主要是此系统和另一个系统间的 | ||||

| Compliant | 802.3ad | 802.3ad | Not 802.3ad | |||

| 默认策略 | 如果没有提供配置,则这是默认策略 |

对于非 IP 流量,公式与 |

对于非 IP 流量,公式与 |

第 4 章 配置 NIC team

网络接口控制器(NIC)team 是一种组合或聚合物理和虚拟网络接口的方法,以提供具有高吞吐量或冗余的逻辑接口。NIC team 使用小内核模块来实现对数据包流和用于其他任务的用户空间服务的快速处理。这样,NIC team 是一种易扩展和可伸缩的解决方案,满足负载均衡和冗余要求。

Red Hat Enterprise Linux 为管理员提供不同的选项来配置团队设备。例如:

-

使用

nmcli使用命令行配置团队连接。 - 使用 RHEL web 控制台使用 Web 浏览器配置组连接。

-

使用

nm-connection-editor应用程序在图形界面中配置组连接。

NIC team 在 Red Hat Enterprise Linux 9 中已弃用。考虑使用网络绑定驱动程序作为替代方案。详情请参阅 配置网络绑定。

4.1. 将 NIC team 配置迁移到网络绑定

网络接口控制器(NIC)team 在 Red Hat Enterprise Linux 9 中已弃用。如果您已经配置了一个可工作的 NIC team,例如,因为您从较早的 RHEL 版本升级了,您可以将配置迁移到由 NetworkManager 管理的网络绑定。

team2bond 工具仅将 team 配置转换为绑定。之后,您必须手动配置绑定的进一步设置,如 IP 地址和 DNS 配置。

先决条件

-

team-team0NetworkManager 连接配置集被配置并管理team0设备。 -

已安装

teamd软件包。

流程

可选:显示

team-team0NetworkManager 连接的 IP 配置:# nmcli connection show team-team0 | grep -E "^ip" ... ipv4.method: manual ipv4.dns: 192.0.2.253 ipv4.dns-search: example.com ipv4.addresses: 192.0.2.1/24 ipv4.gateway: 192.0.2.254 ... ipv6.method: manual ipv6.dns: 2001:db8:1::fffd ipv6.dns-search: example.com ipv6.addresses: 2001:db8:1::1/64 ipv6.gateway: 2001:db8:1::fffe ...将

team0设备的配置导出到 JSON 文件中:# teamdctl team0 config dump actual > /tmp/team0.json删除 NIC team 。例如,如果您在 NetworkManager 中配置了团队,请删除

team-team0连接配置集以及相关端口的配置集:# nmcli connection delete team-team0 # nmcli connection delete team-team0-port1 # nmcli connection delete team-team0-port2

以空运行模式运行

team2bond程序,显示nmcli命令,该命令使用类似设置的网络绑定设置为团队设备:# team2bond --config=/tmp/team0.json --rename=bond0 nmcli con add type bond ifname bond0 bond.options "mode=active-backup,num_grat_arp=1,num_unsol_na=1,resend_igmp=1,miimon=100,miimon=100" nmcli con add type ethernet ifname enp7s0 controller bond0 nmcli con add type ethernet ifname enp8s0 controller bond0

第一个命令包含两个

miimon选项,因为团队配置文件包含两个link_watch条目。请注意,这不会影响创建绑定。如果您将服务绑定到团队的设备名称并希望避免更新或破坏这些服务,请省略

--rename=bond0选项。在这种情况下,team2bond为绑定使用与团队相同的接口名称。-

验证推荐

team2bond工具的绑定选项是否正确。 创建绑定。您可以执行建议的

nmcli命令,或使用--exec-cmd选项重新运行team2bond命令:# team2bond --config=/tmp/team0.json --rename=bond0 --exec-cmd Connection 'bond-bond0' (0241a531-0c72-4202-80df-73eadfc126b5) successfully added. Connection 'bond-port-enp7s0' (38489729-b624-4606-a784-1ccf01e2f6d6) successfully added. Connection 'bond-port-enp8s0' (de97ec06-7daa-4298-9a71-9d4c7909daa1) successfully added.

下一步需要绑定连接配置集的名称(

bond-bond0)。将之前在

team-team0中配置的 IPv4 设置设置为bond-bond0连接:# nmcli connection modify bond-bond0 ipv4.addresses '192.0.2.1/24' # nmcli connection modify bond-bond0 ipv4.gateway '192.0.2.254' # nmcli connection modify bond-bond0 ipv4.dns '192.0.2.253' # nmcli connection modify bond-bond0 ipv4.dns-search 'example.com' # nmcli connection modify bond-bond0 ipv4.method manual

将之前在

team-team0中配置的 IPv6 设置设置为bond-bond0连接:# nmcli connection modify bond-bond0 ipv6.addresses '2001:db8:1::1/64' # nmcli connection modify bond-bond0 ipv6.gateway '2001:db8:1::fffe' # nmcli connection modify bond-bond0 ipv6.dns '2001:db8:1::fffd' # nmcli connection modify bond-bond0 ipv6.dns-search 'example.com' # nmcli connection modify bond-bond0 ipv6.method manual

激活连接:

# nmcli connection up bond-bond0

验证

显示

bond-bond0NetworkManager 连接的 IP 配置:# nmcli connection show bond-bond0 | grep -E "^ip" ... ipv4.method: manual ipv4.dns: 192.0.2.253 ipv4.dns-search: example.com ipv4.addresses: 192.0.2.1/24 ipv4.gateway: 192.0.2.254 ... ipv6.method: manual ipv6.dns: 2001:db8:1::fffd ipv6.dns-search: example.com ipv6.addresses: 2001:db8:1::1/64 ipv6.gateway: 2001:db8:1::fffe ...显示绑定状态:

# cat /proc/net/bonding/bond0 Ethernet Channel Bonding Driver: v5.13.0-0.rc7.51.el9.x86_64 Bonding Mode: fault-tolerance (active-backup) Primary Slave: None Currently Active Slave: enp7s0 MII Status: up MII Polling Interval (ms): 100 Up Delay (ms): 0 Down Delay (ms): 0 Peer Notification Delay (ms): 0 Slave Interface: enp7s0 MII Status: up Speed: Unknown Duplex: Unknown Link Failure Count: 0 Permanent HW addr: 52:54:00:bf:b1:a9 Slave queue ID: 0 Slave Interface: enp8s0 MII Status: up Speed: Unknown Duplex: Unknown Link Failure Count: 0 Permanent HW addr: 52:54:00:04:36:0f Slave queue ID: 0在这个示例中,两个端口都是上线的。

验证绑定故障切换是否正常工作:

- 从主机中临时删除网络电缆。请注意,无法使用命令行正确测试链路失败事件。

显示绑定状态:

# cat /proc/net/bonding/bond0

4.2. 了解控制器和端口接口的默认行为

在使用 NetworkManager 服务管理或排除团队或绑定端口接口故障排除时,请考虑以下默认行为:

- 启动控制器接口不会自动启动端口接口。

- 启动端口接口总会启动控制器接口。

- 停止控制器接口也会停止端口接口。

- 没有端口的控制器可以启动静态 IP 连接。

- 没有端口的控制器在启动 DHCP 连接时会等待端口。

- 当您添加具有载体的端口时,等待端口且具有 DHCP 连接的控制器会完成。

- 当您添加没有载体的端口时,等待端口的具有 DHCP 连接的控制器将继续等待。

4.3. 了解 teamd 服务、运行程序和 link-watchers

团队服务 teamd 控制团队驱动程序的一个实例。这个驱动的实例添加硬件设备驱动程序实例组成一个网络接口组。团队驱动程序向内核提供一个网络接口,如 team0。

teamd 服务对所有团队方法实现通用逻辑。这些功能对不同的负载共享和备份方法(如循环)是唯一的,并由称为 runners 的单独的代码单元来实现。管理员以 JavaScript 对象表示法(JSON)格式指定runners ,在创建实例时,JSON 代码被编译到 teamd 实例中。另外,在使用 NetworkManager 时,您可以在 team.runner 参数中设置 runner ,NetworkManager 会自动创建对应的 JSON 代码。

可用的 runner 如下:

-

broadcast:转换所有端口上的数据。 -

roundrobin:依次转换所有端口上的数据。 -

activebackup:转换一个端口上的数据,而其他端口上的数据则作为备份保留。 -

loadbalance:转换所有具有活跃的 Tx 负载均衡和基于 Berkeley 数据包过滤器(BPF)的 Tx 端口选择器的端口上的数据。 -

random:转换随机选择的端口上的数据。 -

lacp:实现 802.3ad 链路聚合控制协议(LACP)。

teamd 服务使用链路监视器来监控从属设备的状态。可用的 link-watchers 如下:

-

ethtool:libteam库使用ethtool工具来监视链接状态的变化。这是默认的 link-watcher。 -

arp_ping:libteam库使用arp_ping工具来监控使用地址解析协议(ARP)的远端硬件地址是否存在。 -

nsna_ping: 在 IPv6 连接上,libteam库使用来自 IPv6 邻居发现协议的邻居广告和邻居请求功能来监控邻居接口的存在。

每个 runner 都可以使用任何链接监视器,但 lacp 除外。此 runner 只能使用 ethtool 链接监视器。

4.4. 使用 nmcli 配置 NIC team

要在命令行上配置网络接口控制器(NIC)team ,请使用 nmcli 工具。

NIC team 在 Red Hat Enterprise Linux 9 中已弃用。考虑使用网络绑定驱动程序作为替代方案。详情请参阅 配置网络绑定。

前提条件

-

已安装

teamd和NetworkManager-team软件包。 - 在服务器中安装两个或者两个以上物理或者虚拟网络设备。

- 要将以太网设备用作组的端口,必须在服务器中安装物理或者虚拟以太网设备并连接到交换机。

要使用 bond、bridge 或 VLAN 设备作为团队的端口,您可以在创建团队时创建这些设备,或者预先创建它们,如下所述:

流程

创建团队接口:

# nmcli connection add type team con-name team0 ifname team0 team.runner activebackup此命令创建一个名为

team0的 NIC team ,它使用activebackuprunner 。可选:设置链接监视器。例如,要在

team0连接配置文件中设置ethtool链接监视器:# nmcli connection modify team0 team.link-watchers "name=ethtool"链路监视器支持不同的参数。要为链路监视器设置参数,请在

name属性中以空格分隔的方式来指定它们。请注意,name 属性必须用引号括起来。例如,要使用ethtool链接监视器,并将其delay-up参数设置为2500毫秒(2.5 秒):# nmcli connection modify team0 team.link-watchers "name=ethtool delay-up=2500"要设置多个链路监视器,每个都使用特定的参数,不同的连接监视器以逗号分隔。以下示例使用

delay-up参数设置ethtool链接监视器,使用source-host和target-host参数设置arp_ping链路监视器:# nmcli connection modify team0 team.link-watchers "name=ethtool delay-up=2, name=arp_ping source-host=192.0.2.1 target-host=192.0.2.2"显示网络接口,并记录您要添加到团队中的接口名称:

# nmcli device status DEVICE TYPE STATE CONNECTION enp7s0 ethernet disconnected -- enp8s0 ethernet disconnected -- bond0 bond connected bond0 bond1 bond connected bond1 ...在本例中:

-

没有配置

enp7s0和enp8s0。要将这些设备用作端口,请在下一步中添加连接配置集。请注意,您只能在没有分配给任何连接的团队中使用以太网接口。 -

bond0和bond1已有连接配置文件。要将这些设备用作端口,请在下一步中修改其配置集。

-

没有配置

为团队分配端口接口:

如果没有配置您要分配给团队的接口,为其创建新的连接配置集:

# nmcli connection add type ethernet port-type team con-name team0-port1 ifname enp7s0 controller team0 # nmcli connection add type ethernet port--type team con-name team0-port2 ifname enp8s0 controller team0

这些命令为

enp7s0和enp8s0创建配置文件,并将它们添加到team0连接中。将现有的连接配置文件分配给团队:

将这些连接的

controller参数设置为team0:# nmcli connection modify bond0 controller team0 # nmcli connection modify bond1 controller team0

这些命令将名为

bond0和bond1的现有连接配置文件分配给team0连接。重新激活连接:

# nmcli connection up bond0 # nmcli connection up bond1

配置 IPv4 设置:

如果您计划将此 team 设备用作其它设备的端口,请输入:

# nmcli connection modify team0 ipv4.method disabled- 要使用 DHCP,不需要进行任何操作。

要为

team0连接设置静态 IPv4 地址、网络掩码、默认网关和 DNS 服务器设置,请输入:# nmcli connection modify team0 ipv4.addresses '192.0.2.1/24' ipv4.gateway '192.0.2.254' ipv4.dns '192.0.2.253' ipv4.dns-search 'example.com' ipv4.method manual

配置 IPv6 设置:

如果您计划将此 team 设备用作其它设备的端口,请输入:

# nmcli connection modify team0 ipv6.method disabled- 要使用无状态地址自动配置(SLAAC),则不需要任何操作。

要为

team0连接设置静态 IPv6 地址、网络掩码、默认网关和 DNS 服务器设置,请输入:# nmcli connection modify team0 ipv6.addresses '2001:db8:1::1/64' ipv6.gateway '2001:db8:1::fffe' ipv6.dns '2001:db8:1::fffd' ipv6.dns-search 'example.com' ipv6.method manual

激活连接:

# nmcli connection up team0

验证

显示团队状态:

# teamdctl team0 state setup: runner: activebackup ports: enp7s0 link watches: link summary: up instance[link_watch_0]: name: ethtool link: up down count: 0 enp8s0 link watches: link summary: up instance[link_watch_0]: name: ethtool link: up down count: 0 runner: active port: enp7s0在这个示例中,两个端口都是上线的。

其他资源

- 配置 NetworkManager 以避免使用特定配置集提供默认网关

- 了解 teamd 服务、运行程序和 link-watchers

-

您系统上的

nm-settings (5)和teamd.conf (5)手册页

4.5. 使用 RHEL web 控制台配置 NIC team

如果您喜欢使用基于 Web 浏览器的界面管理网络设置,那么请使用 RHEL web 控制台配置网络接口控制器(NIC)team 。

NIC team 在 Red Hat Enterprise Linux 9 中已弃用。考虑使用网络绑定驱动程序作为替代方案。详情请参阅 配置网络绑定。

先决条件

-

已安装

teamd和NetworkManager-team软件包。 - 在服务器中安装两个或者两个以上物理或者虚拟网络设备。

- 要将以太网设备用作组的端口,必须在服务器中安装物理或者虚拟以太网设备并连接到交换机。

要将 bond、bridge 或 VLAN 设备用作团队的端口,请预先创建它们,如下所述:

- 您已安装了 RHEL 9 web 控制台。

- 您已启用了 cockpit 服务。

您的用户帐户被允许登录到 web 控制台。

具体步骤请参阅安装并启用 Web 控制台。

流程

登录到 RHEL 9 web 控制台。

详情请参阅 登录到 web 控制台。

-

在屏幕左侧的导航中选择

Networking选项卡。 -

在

Interfaces部分点 。 - 输入您要创建的团队设备名称。

- 选择应该是团队端口的接口。

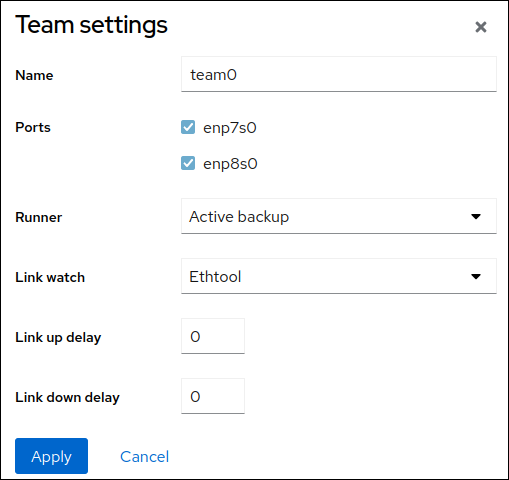

选择团队的运行程序。

如果您选择

Load balancing或802.3ad LACP,Web 控制台会显示额外的Balancer字段。设置链接监视器:

-

如果您选择

Ethtool,请设置链接并关闭延迟。 -

如果您设置了

ARP ping或NSNA ping,还要设置 ping 间隔并 ping 目标。

-

如果您选择

- 点。

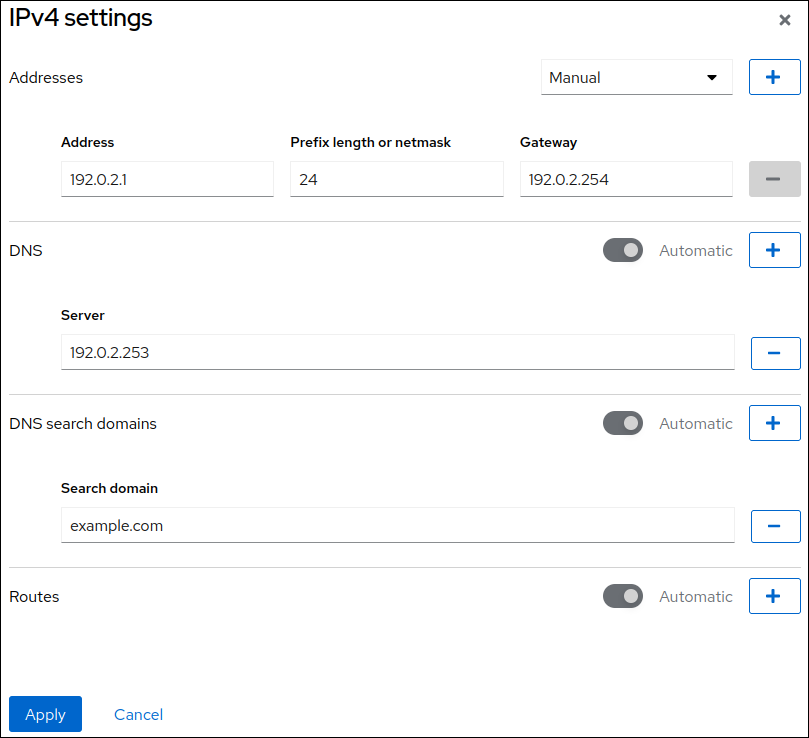

默认情况下,团队使用动态 IP 地址。如果要设置静态 IP 地址:

-

在

Interfaces部分点团队的名称。 -

点您要配置的协议旁的

Edit。 -

选择

Addresses旁的Manual,并输入 IP 地址、前缀和默认网关。 -

在

DNS部分,点 按钮,并输入 DNS 服务器的 IP 地址。重复此步骤来设置多个 DNS 服务器。 -

在

DNS search domains部分中,点 按钮并输入搜索域。 如果接口需要静态路由,请在

Routes部分配置它们。

- 点

-

在

验证

在屏幕左侧的导航中选择

Networking选项卡,并检查接口上是否有传入和传出流量。

显示团队状态:

# teamdctl team0 state setup: runner: activebackup ports: enp7s0 link watches: link summary: up instance[link_watch_0]: name: ethtool link: up down count: 0 enp8s0 link watches: link summary: up instance[link_watch_0]: name: ethtool link: up down count: 0 runner: active port: enp7s0在这个示例中,两个端口都是上线的。

4.6. 使用 nm-connection-editor 配置 NIC team

如果使用带有图形界面的 Red Hat Enterprise Linux,您可以使用 nm-connection-editor 应用程序配置网络接口控制器(NIC)team。

请注意:nm-connection-editor 只能向团队添加新端口。要使用现有连接配置文件作为端口,请使用 nmcli 工具创建 team ,如 使用 nmcli 配置 NIC team 中所述。

NIC team 在 Red Hat Enterprise Linux 9 中已弃用。考虑使用网络绑定驱动程序作为替代方案。详情请参阅 配置网络绑定。

前提条件

-

已安装

teamd和NetworkManager-team软件包。 - 在服务器中安装两个或者两个以上物理或者虚拟网络设备。

- 要将以太网设备用作组的端口,必须在服务器中安装物理或者虚拟以太网设备。

- 要使用 team、bond 或 VLAN 设备作为团队的端口,请确保这些设备还没有配置。

流程

打开一个终端,输入

nm-connection-editor:$ nm-connection-editor- 点击 按钮来添加一个新的连接。

- 选择 Team 连接类型,然后单击 。

在 Team 选项卡中:

- 可选:在 Interface name 字段中设置团队接口的名称。

点 按钮为网络接口添加新连接配置集,并将配置集作为端口添加到团队。

- 选择接口的连接类型。例如,为有线连接选择 Ethernet。

- 可选:为端口设置连接名称。

- 如果为以太网设备创建连接配置文件,请打开 Ethernet 选项卡,在 Device 字段中选择您要作为端口添加到团队的网络接口。如果您选择了不同的设备类型,请相应地进行配置。请注意,您只能在没有分配给任何连接的团队中使用以太网接口。

- 点 。

对您要添加到团队的每个接口重复前面的步骤。

点 按钮将高级选项设置为团队连接。

- 在 Runner 选项卡中,选择 runner。

- 在 Link Watcher 选项卡中,设置链接监视器及其可选设置。

- 点。

在 IPv4 Settings 和 IPv6 Settings 标签页中配置 IP 地址设置:

- 如果您计划将此网桥设备用作其它设备的端口,请将 Method 字段设置为 Disabled。

- 要使用 DHCP,请将 Method 字段保留为默认值 Automatic (DHCP)。

要使用静态 IP 设置,请将 Method 字段设置为 Manual,并相应地填写字段:

- 点 。

-

关闭

nm-connection-editor。

验证

显示团队状态:

# teamdctl team0 state setup: runner: activebackup ports: enp7s0 link watches: link summary: up instance[link_watch_0]: name: ethtool link: up down count: 0 enp8s0 link watches: link summary: up instance[link_watch_0]: name: ethtool link: up down count: 0 runner: active port: enp7s0

第 5 章 配置 VLAN 标记

Virtual Local Area Network (VLAN) 是物理网络中的一个逻辑网络。当 VLAN 接口通过接口时,VLAN 接口标签带有 VLAN ID 的数据包,并删除返回的数据包的标签。您可以在另一个接口(如以太网、绑定、团队或桥接设备)上创建 VLAN 接口。这些接口被称为 父接口。

Red Hat Enterprise Linux 为管理员提供不同的选项来配置 VLAN 设备。例如:

-

使用

nmcli使用命令行配置 VLAN 标记。 - 通过 RHEL web 控制台使用 Web 浏览器配置 VLAN 标记。

-

使用

nmtui在基于文本的用户界面中配置 VLAN 标记。 -

使用

nm-connection-editor应用程序在图形界面中配置连接。 -

使用

nmstatectl通过 Nmstate API 配置连接。 - 使用 RHEL 系统角色自动化一个或多个主机上的 VLAN 配置。

5.1. 使用 nmcli 配置 VLAN 标记

您可以使用 nmcli 实用程序在命令行中配置 Virtual Local Area Network (VLAN) 标记。

前提条件

- 您计划用作虚拟 VLAN 接口的父接口支持 VLAN 标签。

如果您在绑定接口之上配置 VLAN:

- 绑定的端口是上线的。

-

这个绑定没有使用

fail_over_mac=follow选项进行配置。VLAN 虚拟设备无法更改其 MAC 地址以匹配父设备的新 MAC 地址。在这种情况下,流量仍会与不正确的源 MAC 地址一同发送。 -

这个绑定通常不会预期从 DHCP 服务器或 IPv6 自动配置获取 IP 地址。在创建绑定时通过设置

ipv4.method=disable和ipv6.method=ignore选项来确保它。否则,如果 DHCP 或 IPv6 自动配置在一段时间后失败,接口可能会关闭。

- 主机连接到的交换机被配置为支持 VLAN 标签。详情请查看您的交换机文档。

流程

显示网络接口:

# nmcli device status DEVICE TYPE STATE CONNECTION enp1s0 ethernet disconnected enp1s0 bridge0 bridge connected bridge0 bond0 bond connected bond0 ...创建 VLAN 接口。例如,要创建一个使用

enp1s0作为其父接口,使用 VLAN ID10标记数据包,名为vlan10的 VLAN 接口,请输入:# nmcli connection add type vlan con-name vlan10 ifname vlan10 vlan.parent enp1s0 vlan.id 10请注意,VLAN 必须在范围

0到4094之间。默认情况下,VLAN 连接会继承上级接口的最大传输单元(MTU)。另外,还可设置不同的 MTU 值:

# nmcli connection modify vlan10 ethernet.mtu 2000配置 IPv4 设置:

如果您计划将此 VLAN 设备用作其它设备的端口,请输入:

# nmcli connection modify vlan10 ipv4.method disabled- 要使用 DHCP,不需要进行任何操作。

要为

vlan10连接设置静态 IPv4 地址、网络掩码、默认网关和 DNS 服务器设置,请输入:# nmcli connection modify vlan10 ipv4.addresses '192.0.2.1/24' ipv4.gateway '192.0.2.254' ipv4.dns '192.0.2.253' ipv4.method manual

配置 IPv6 设置:

如果您计划将此 VLAN 设备用作其它设备的端口,请输入:

# nmcli connection modify vlan10 ipv6.method disabled- 要使用无状态地址自动配置(SLAAC),则不需要任何操作。

要为

vlan10连接设置静态 IPv6 地址、网络掩码、默认网关和 DNS 服务器设置,请输入:# nmcli connection modify vlan10 ipv6.addresses '2001:db8:1::1/32' ipv6.gateway '2001:db8:1::fffe' ipv6.dns '2001:db8:1::fffd' ipv6.method manual

激活连接:

# nmcli connection up vlan10

验证

验证设置:

# ip -d addr show vlan10 4: vlan10@enp1s0: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc noqueue state UP group default qlen 1000 link/ether 52:54:00:72:2f:6e brd ff:ff:ff:ff:ff:ff promiscuity 0 vlan protocol 802.1Q id 10 <REORDER_HDR> numtxqueues 1 numrxqueues 1 gso_max_size 65536 gso_max_segs 65535 inet 192.0.2.1/24 brd 192.0.2.255 scope global noprefixroute vlan10 valid_lft forever preferred_lft forever inet6 2001:db8:1::1/32 scope global noprefixroute valid_lft forever preferred_lft forever inet6 fe80::8dd7:9030:6f8e:89e6/64 scope link noprefixroute valid_lft forever preferred_lft forever

其他资源

-

您系统上的

nm-settings (5)手册页

5.2. 使用 nmcli 配置嵌套 VLAN

802.1ad 是用于虚拟局域网(VLAN)标记的协议。它也被称为 Q-in-Q 标记。您可以使用此技术在单个以太网框架中创建多个 VLAN 标签,以实现以下优点:

- 通过在 VLAN 中创建多个隔离网络段来提高网络可扩展性。这可让您将大型网络分段并组织成较小的、可管理的单元。

- 通过隔离和控制不同类型的网络流量,改进了流量管理。这可以提高网络性能并减少网络拥塞。

- 通过创建较小的,多个目标网络段,实现高效资源利用率。

- 通过隔离网络流量,降低未授权访问敏感数据的风险,提高了安全性。

前提条件

- 您计划用作虚拟 VLAN 接口的父接口支持 VLAN 标签。

如果您在绑定接口之上配置 VLAN:

- 绑定的端口是上线的。

-

这个绑定没有使用

fail_over_mac=follow选项进行配置。VLAN 虚拟设备无法更改其 MAC 地址以匹配父设备的新 MAC 地址。在这种情况下,流量仍会与不正确的源 MAC 地址一同发送。 -

这个绑定通常不会预期从 DHCP 服务器或 IPv6 自动配置获取 IP 地址。在创建绑定时通过设置

ipv4.method=disable和ipv6.method=ignore选项来确保它。否则,如果 DHCP 或 IPv6 自动配置在一段时间后失败,接口可能会关闭。

- 主机连接到的交换机被配置为支持 VLAN 标签。详情请查看您的交换机文档。

流程

显示物理网络设备:

# nmcli device status DEVICE TYPE STATE CONNECTION enp1s0 ethernet connected enp1s0 ...创建基础 VLAN 接口。例如,要创建一个名为

vlan10的基本 VLAN 接口,它使用enp1s0作为其父接口,以及 VLAN ID 为10的标记数据包,请输入:# nmcli connection add type vlan con-name vlan10 dev enp1s0 vlan.id 10请注意,VLAN 必须在范围

0到4094之间。默认情况下,VLAN 连接会继承上级接口的最大传输单元(MTU)。另外,还可设置不同的 MTU 值:

# nmcli connection modify vlan10 ethernet.mtu 2000在基本 VLAN 接口之上创建嵌套的 VLAN 接口:

# nmcli connection add type vlan con-name vlan10.20 dev enp1s0.10 id 20 vlan.protocol 802.1ad此命令会在父 VLAN 连接

vlan10上创建一个新的 VLAN 连接,名称为vlan10.20,VLAN ID 为20。dev选项指定父网络设备。在本例中,是enp1s0.10。vlan.protocol选项指定 VLAN 封装协议。在本例中,它是802.1ad(Q-in-Q)。配置嵌套 VLAN 接口的 IPv4 设置:

- 要使用 DHCP,不需要进行任何操作。

要为

vlan10.20连接设置静态 IPv4 地址、网络掩码、默认网关和 DNS 服务器设置,请输入:# nmcli connection modify vlan10.20 ipv4.method manual ipv4.addresses 192.0.2.1/24 ipv4.gateway 192.0.2.254 ipv4.dns 192.0.2.200

配置嵌套 VLAN 接口的 IPv6 设置:

- 要使用无状态地址自动配置(SLAAC),则不需要任何操作。

要为 vlan10 连接设置静态 IPv4 地址、网络掩码、默认网关和 DNS 服务器设置,请输入:

# nmcli connection modify vlan10 ipv4.addresses '192.0.2.1/24' ipv4.gateway '192.0.2.254' ipv4.dns '192.0.2.253' ipv4.method manual

激活配置文件:

# nmcli connection up vlan10.20

验证

验证嵌套 VLAN 接口的配置:

# ip -d addr show enp1s0.10.20 10: enp1s0.10.20@enp1s0.10: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc noqueue state UP group default qlen 1000 link/ether 52:54:00:d2:74:3e brd ff:ff:ff:ff:ff:ff promiscuity 0 minmtu 0 maxmtu 65535 vlan protocol 802.1ad id 20 <REORDER_HDR> numtxqueues 1 numrxqueues 1 gso_max_size 65536 gso_max_segs 65535 tso_max_size 65536 tso_max_segs 65535 gro_max_size 65536 inet 192.0.2.1/24 brd 192.0.2.255 scope global noprefixroute enp1s0.10.20 valid_lft forever preferred_lft forever inet6 2001:db8:1::1/32 scope global noprefixroute valid_lft forever preferred_lft forever inet6 fe80::ce3b:84c5:9ef8:d0e6/64 scope link noprefixroute valid_lft forever preferred_lft forever

其他资源

-

您系统上的

nm-settings (5)手册页

5.3. 使用 RHEL web 控制台配置 VLAN 标记

如果您更喜欢在 RHEL web 控制台中使用基于 Web 浏览器的界面管理网络设置,您可以配置 VLAN 标记。

前提条件

- 您计划用作虚拟 VLAN 接口的父接口支持 VLAN 标签。

如果您在绑定接口之上配置 VLAN:

- 绑定的端口是上线的。

-

这个绑定没有使用

fail_over_mac=follow选项进行配置。VLAN 虚拟设备无法更改其 MAC 地址以匹配父设备的新 MAC 地址。在这种情况下,流量仍会与不正确的源 MAC 地址一同发送。 - 这个绑定通常不会预期从 DHCP 服务器或 IPv6 自动配置获取 IP 地址。禁用 IPv4 和 IPv6 协议创建绑定以确保它。否则,如果 DHCP 或 IPv6 自动配置在一段时间后失败,接口可能会关闭。

- 主机连接到的交换机被配置为支持 VLAN 标签。详情请查看您的交换机文档。

- 您已安装了 RHEL 9 web 控制台。

- 您已启用了 cockpit 服务。

您的用户帐户被允许登录到 web 控制台。

具体步骤请参阅安装并启用 Web 控制台。

流程

登录到 RHEL 9 web 控制台。

详情请参阅 登录到 web 控制台。

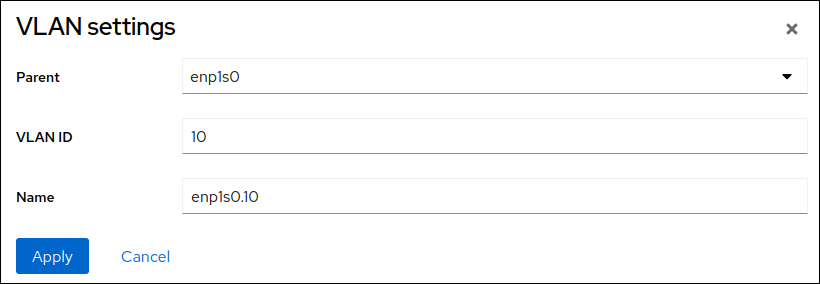

-

在屏幕左侧的导航中选择

Networking选项卡。 -

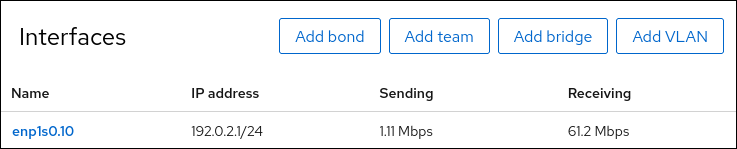

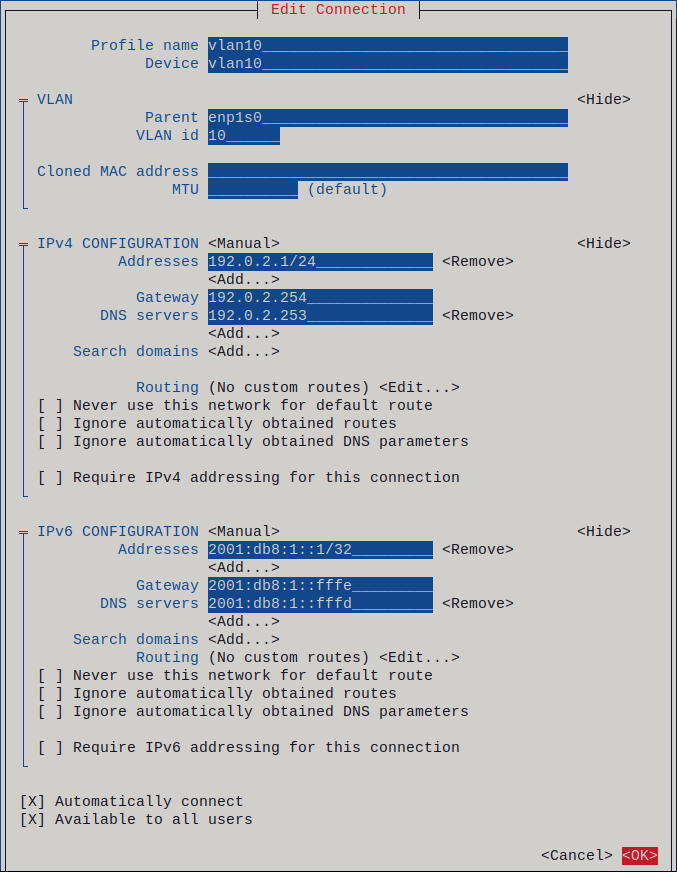

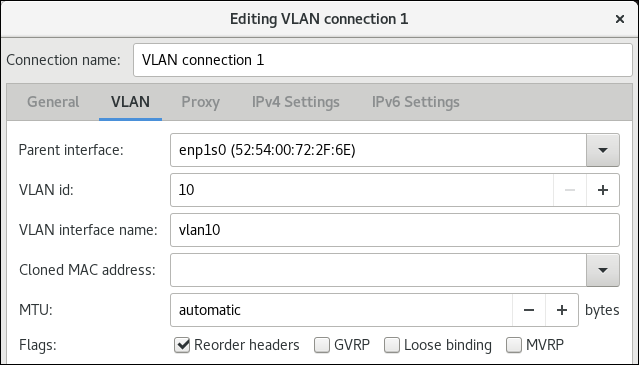

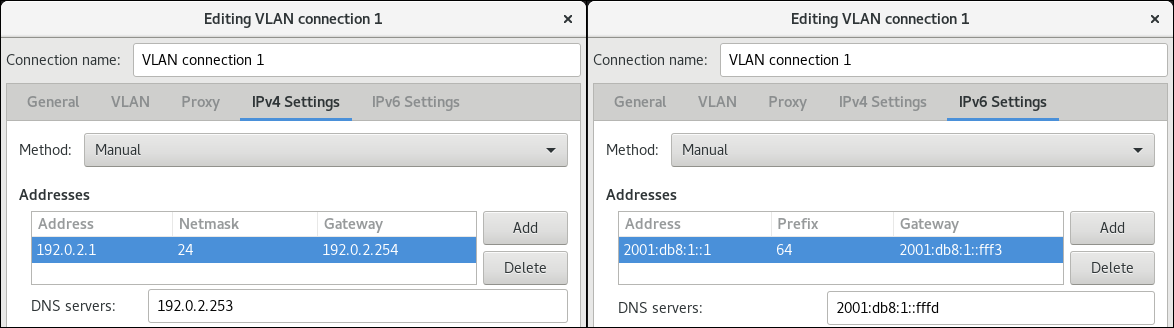

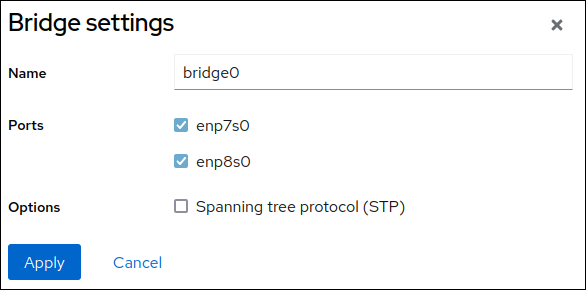

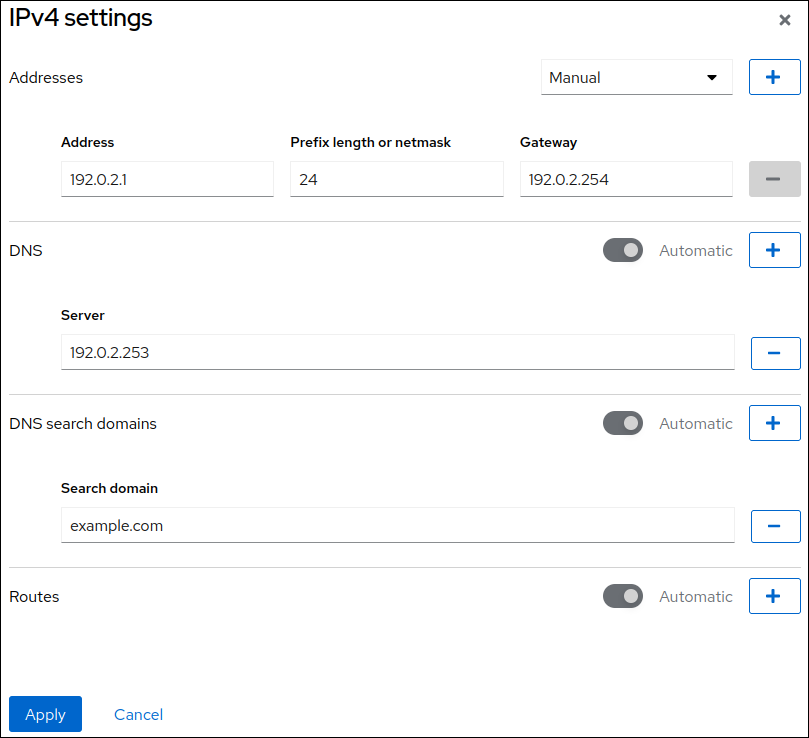

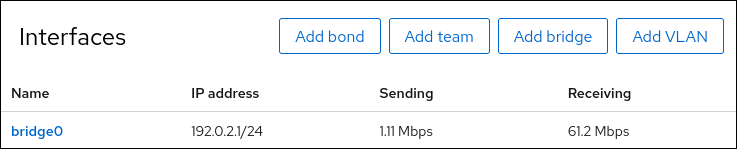

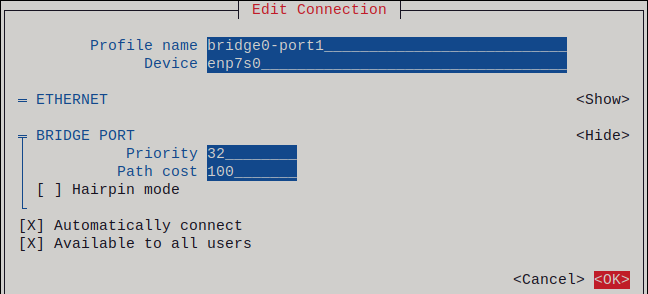

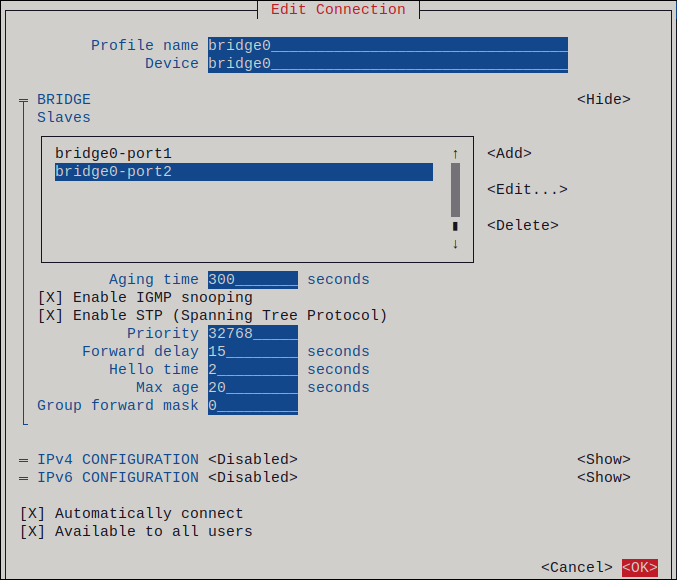

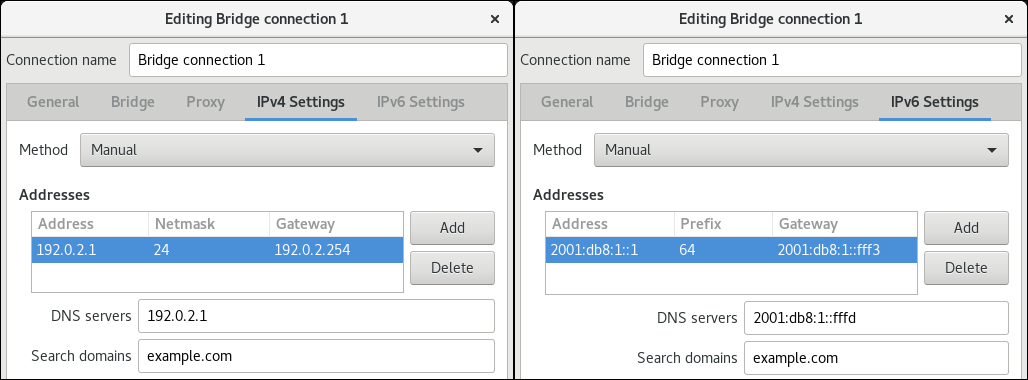

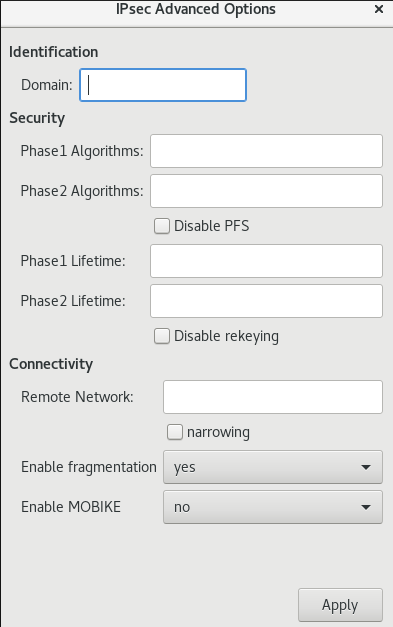

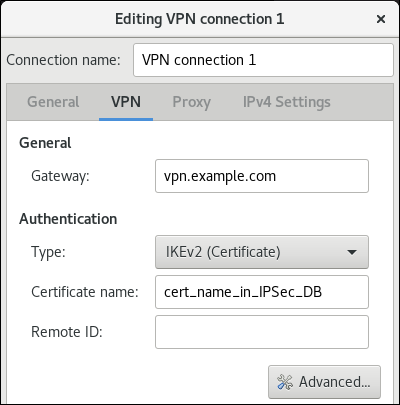

在