配置数据网格缓存

Red Hat Data Grid

Data Grid 是一个高性能分布式内存数据存储。

- 无架构数据结构

- 将不同对象存储为键值对的灵活性。

- 基于网格的数据存储

- 旨在在集群中分发和复制数据。

- 弹性扩展

- 动态调整节点数量,以便在不中断服务的情况下满足需求。

- 数据互操作性

- 从不同端点在网格中存储、检索和查询数据。

Data Grid 文档

红帽客户门户网站中提供了 Data Grid 的文档。

Data Grid 下载

访问红帽客户门户上的 Data Grid 软件下载。

您必须有一个红帽帐户才能访问和下载数据中心软件。

使开源包含更多

红帽致力于替换我们的代码、文档和 Web 属性中存在问题的语言。我们从这四个术语开始:master、slave、黑名单和白名单。由于此项工作十分艰巨,这些更改将在即将推出的几个发行版本中逐步实施。详情请查看 CTO Chris Wright 的信息。

第 1 章 Data Grid 缓存

Data Grid 缓存提供灵活的内存中数据存储,您可以配置它们以适应用例,例如:

- 使用高速本地缓存提高应用程序性能.

- 通过减少写入操作的卷来优化数据库。

- 为跨集群的一致性数据提供弹性和持久性。

1.1. Cache API

cache<K,V > 是 Data Grid 的核心接口,扩展 java.util.concurrent.ConcurrentMap。

缓存条目是 key:value 格式的高度并发数据结构,它支持广泛的、可配置的数据类型,从简单字符串到更复杂的对象。

1.2. 缓存管理器

CacheManager API 是与 Data Grid 交互的入口点。缓存管理器控制缓存生命周期;创建、修改和删除缓存实例。缓存管理器还提供集群管理和监控,以及跨节点执行代码的功能。

Data Grid 提供两个 CacheManager 实现:

EmbeddedCacheManager- 在与客户端应用程序相同的 Java 虚拟机(JVM)中运行 Data Grid 时,缓存的入口点。

RemoteCacheManager-

在其自己的 JVM 中运行 Data Grid 服务器时的缓存入口点。当您实例化

RemoteCacheManager时,它会通过 Hot Rod 端点建立与 Data Grid 服务器的持久 TCP 连接。

嵌入式和远程缓存 管理器 实施共享一些方法和属性。但是,嵌入式CacheManager 和 之间存在语义差异。

RemoteCacheManager

1.3. 缓存模式

Data Grid 缓存管理器可以创建和管理使用不同模式的多个缓存。例如,您可以使用与 invalidation 模式进行本地缓存、分布式缓存和缓存相同的缓存管理器。

- Local

- Data Grid 作为单一节点运行,永远不会在缓存条目上复制读取或写入操作。

- 复制

- 网格复制集群中所有节点上的所有缓存条目,并且仅执行本地读取操作。

- 分布式

-

网格在集群的一个节点中复制缓存条目,并将条目分配给固定所有者节点。

Data Grid 从所有者节点请求读取操作,以确保它返回正确的值。 - invalidation

- 当操作修改缓存中的条目时,Data Grid 会从所有节点中驱除过时的数据。Data Grid 仅执行本地读取操作。

1.3.1. 缓存模式比较

您应选择的缓存模式取决于您的数据所需的质量和保证。

下表总结了缓存模式的主要区别:

| 缓存模式 | clustered? | 读取性能 | 写性能 | 容量 | 可用性 | 功能 |

|---|---|---|---|---|---|---|

| Local | 否 | 高 (本地) | 高 (本地) | 单一节点 | 单一节点 | complete |

| Simple(简单) | 否 | 最高 (本地) | 最高 (本地) | 单一节点 | 单一节点 | 部分: 无事务、持久性或索引。 |

| invalidation | 是 | 高 (本地) | 低 (所有节点,无数据) | 单一节点 | 单一节点 | 部分: 无索引。 |

| 复制 | 是 | 高 (本地) | 最低 (所有节点) | 最小节点 | 所有节点 | complete |

| 分布式 | 是 | 中 (所有者) | 中 (所有者节点) | 所有节点容量总和除以所有者数。 | 所有者节点 | complete |

| scattered | 是 | 中 (主) | 更高 (单个 RPC) | 所有节点容量总和除以 2 个。 | 所有者节点 | 部分: 无事务。 |

1.4. 本地缓存

Data Grid 提供与 ConcurrentHashMap 类似的本地缓存模式。

缓存提供比简单映射更多的功能,包括直写和写入持久性存储,以及驱除和过期等管理功能。

Data Grid Cache API 扩展 Java 中的 ConcurrentMap API,使其可以轻松地从映射迁移到 Data Grid 缓存。

本地缓存配置

XML

<local-cache name="mycache"

statistics="true">

<encoding media-type="application/x-protostream"/>

</local-cache>

JSON

{

"local-cache": {

"name": "mycache",

"statistics": "true",

"encoding": {

"media-type": "application/x-protostream"

}

}

}

YAML

localCache:

name: "mycache"

statistics: "true"

encoding:

mediaType: "application/x-protostream"

1.4.1. 简单缓存

简单的缓存是禁用对以下功能的支持的本地缓存类型:

- 事务和调用批处理

- 持久性存储

- 自定义拦截器

- 索引

- transcoding

但是,您可以将其他 Data Grid 功能与简单缓存一起使用,如过期、驱除、统计信息和安全功能。如果您配置了一个与简单缓存不兼容的功能,Data Grid 会抛出异常。

简单缓存配置

XML

<local-cache simple-cache="true" />

JSON

{

"local-cache" : {

"simple-cache" : "true"

}

}

YAML

localCache: simpleCache: "true"

第 2 章 集群缓存

您可以在 Data Grid 集群中创建在跨节点间复制数据的嵌入式和远程缓存。

2.1. 复制的缓存

Data Grid 将缓存中的所有条目复制到集群中的所有节点。每个节点都可以在本地执行读取操作。

复制缓存提供了一种快速轻松地在集群中共享状态的方法,但适用于小于 10 个节点的集群。由于复制请求数量与集群中的节点数量线性扩展,所以使用带有更大集群的复制缓存会降低性能。但是,您可以将 UDP 多播用于复制请求来提高性能。

每个密钥都有一个主所有者,用于序列化数据容器更新,以提供一致性。

图 2.1. 复制缓存

同步或异步复制

-

同步复制会阻止调用者(例如,在

cache.put (key, value)上),直到修改成功复制到集群中的所有节点。 - 异步复制在后台执行复制,写入操作会立即返回。不建议异步复制,因为远程节点上发生的通信错误或错误不会向调用者报告。

Transactions

如果启用了事务,则不会通过主所有者复制写入操作。

使用 pesimistic locking 时,每个写入都会触发锁定消息,该消息会广播到所有节点。在事务提交过程中,originator 广播一阶段准备消息和解锁消息(可选)。one-phase 准备或解锁信息都是 fire-and-forget。

使用最佳锁定时,源器广播准备消息、提交消息和解锁消息(可选)。同样,1phase 准备或解锁信息都是 fire-and-forget。

2.2. 分布式缓存

Data Grid 会尝试在缓存中保留任何条目的固定数量(配置为 numOwners )。这允许分布式缓存线性扩展,在向集群添加节点时存储更多数据。

当节点加入并离开集群时,当键有超过个或小于 numOwners 副本时,会出现一些时间。特别是,如果 numOwners 节点存在快速连续,某些条目将会丢失,因此我们表示分布式缓存容许 numOwners - 1 节点失败。

副本数代表在性能和数据的持久性之间权衡。您维护的更多副本,性能越低,但会降低由于服务器或网络故障而丢失数据的风险。

Data Grid 将密钥的所有者分成一个 主要所有者,它将协调对密钥的写入,以及零个或多个 备份所有者。

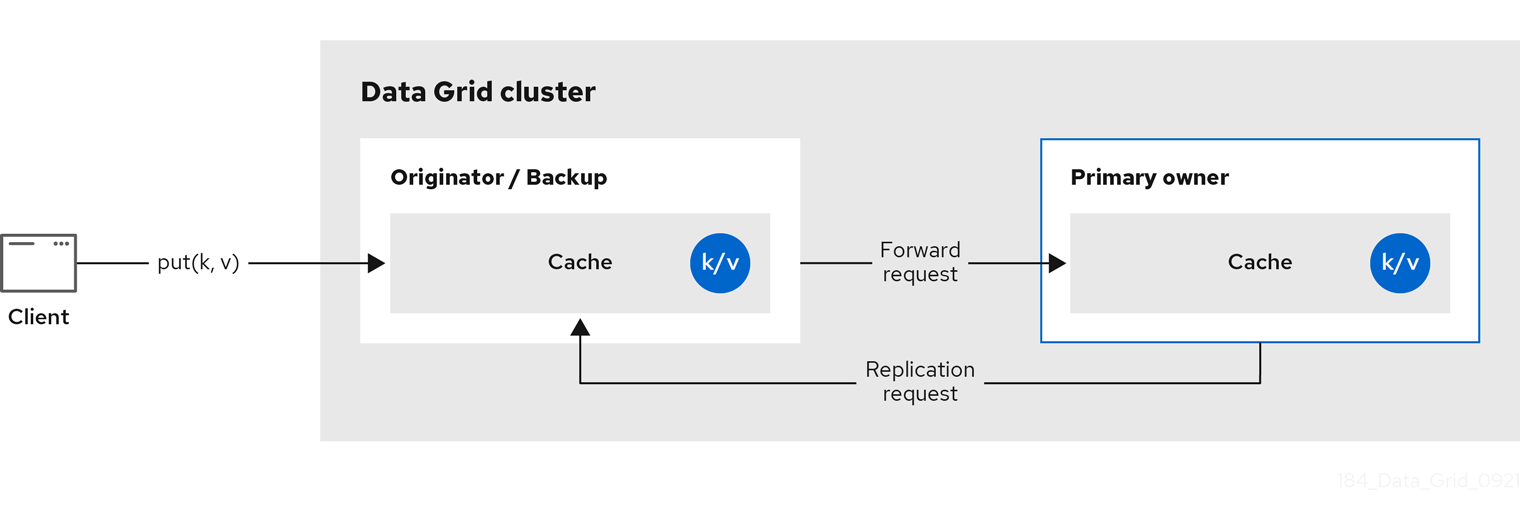

下图显示了客户端发送到备份所有者的写入操作。在这种情况下,备份节点将写入转发到主所有者,然后将写入复制到备份。

图 2.2. 集群复制

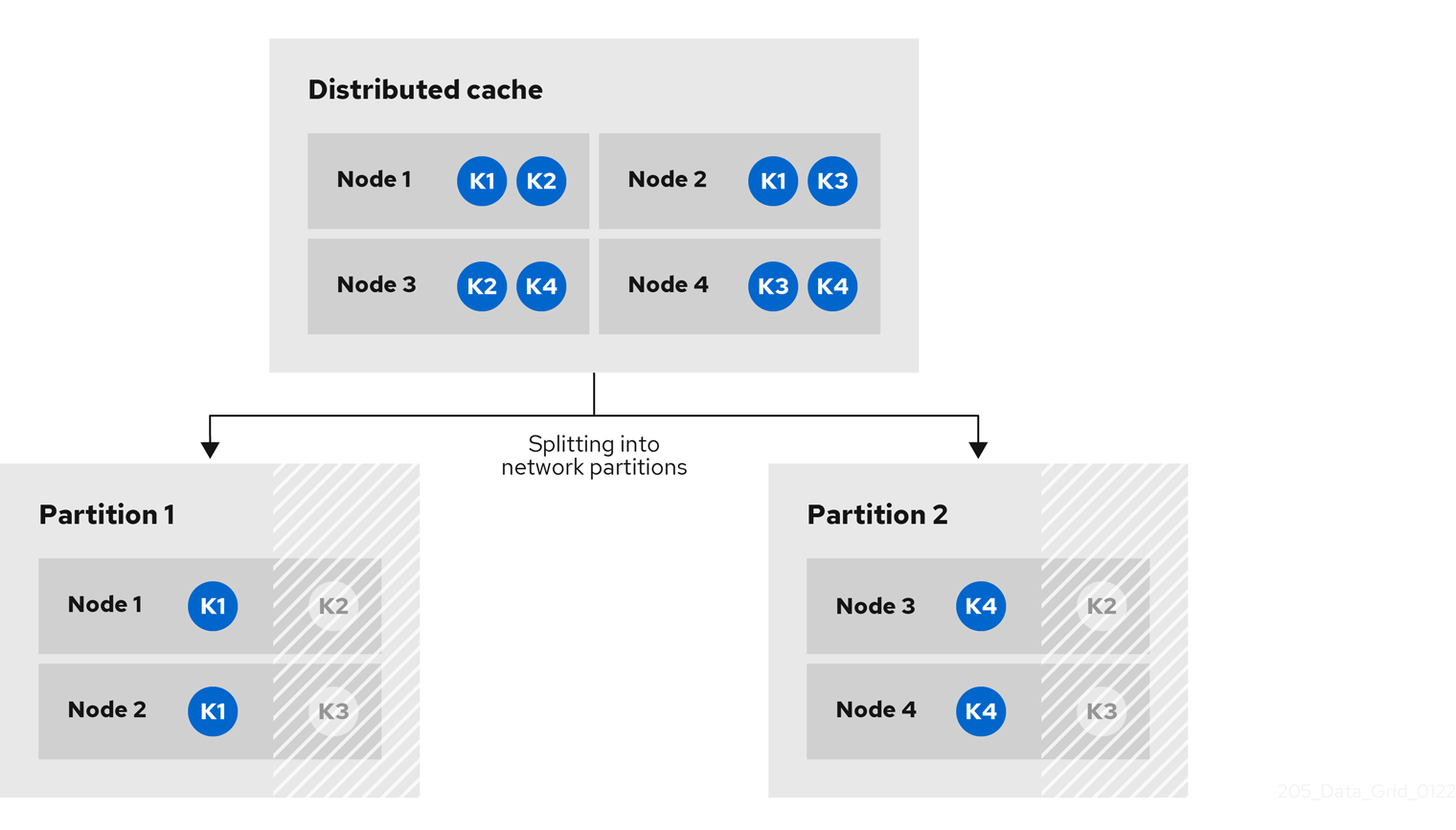

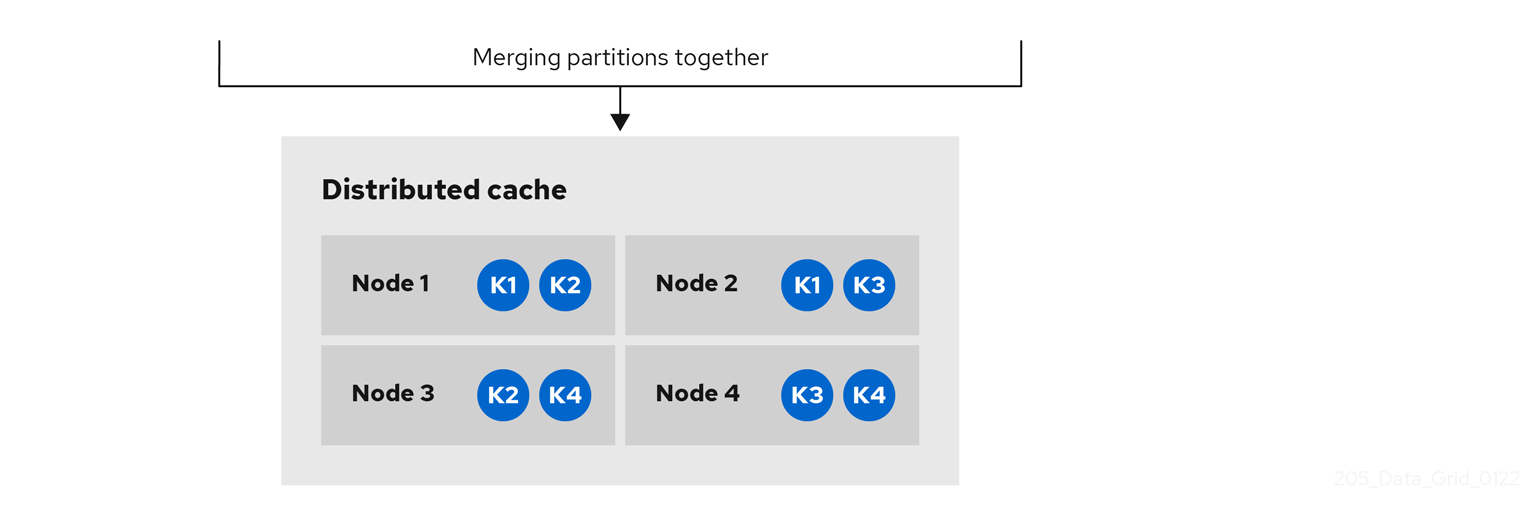

图 2.3. 分布式缓存

读取操作

读取操作从主所有者请求值。如果主所有者没有以合理的时间响应,Data Grid 也从备份所有者请求值。

如果本地缓存中存在密钥,或者所有所有者都较慢,则读取操作可能需要 0 个信息,或者最多 2 个 * numOwners 信息。

写操作

写入操作最多会导致 2 个 * numOwners 信息。来自 originator 到主所有者和 numOwners - 1 消息从主到备份节点的消息以及相应的确认消息。

缓存拓扑更改可能会导致读取和写入操作重试和额外信息。

同步或异步复制

不建议异步复制,因为它可能会丢失更新。除了丢失更新外,当线程写入到键时,异步分布式缓存也可以看到 stale 值,然后立即读取同一密钥。

Transactions

事务分布式缓存将 lock/prepare/commit/unlock 消息发送到受影响的节点,这意味着至少有一个密钥受事务影响。作为优化,如果事务写入单个密钥,并且 originator 是密钥的主所有者,则不会复制锁定信息。

2.2.1. 读取一致性

即使是同步复制,分布式缓存也不可线性。对于事务缓存,它们不支持序列化/快照隔离。

例如,线程正在执行单个放置请求:

cache.get(k) -> v1 cache.put(k, v2) cache.get(k) -> v2

但是另一个线程可能会以不同顺序看到值:

cache.get(k) -> v2 cache.get(k) -> v1

该原因是从任何所有者返回值,具体取决于主所有者回复的速度。写入不是所有所有者的原子性。实际上,只有在从备份收到确认后,才会提交更新。在主等待备份的确认消息时,从备份中读取会显示新值,但从主读取将看到旧值。

2.2.2. 密钥所有权

分布式缓存将条目分成固定数量的片段,并将每个片段分配给所有者节点列表。复制缓存执行相同的操作,但每个节点都是一个所有者。

owners 列表中的第一个节点 是主所有者。列表中的其他节点是 备份所有者。当缓存拓扑更改时,因为节点加入或离开集群时,片段所有权表会广播到每个节点。这允许节点定位密钥,而无需为每个密钥发出多播请求或维护元数据。

numSegments 属性配置可用的片段数量。但是,除非集群重启,片段数量不会改变。

同样,键到网段映射无法更改。无论集群拓扑更改是什么,键必须始终映射到同一片段。务必要确保 key-to-segment 映射平均分配分配给每个节点的片段数量,同时尽量减少集群拓扑更改时必须移动的片段数量。

| 一致的哈希工厂实现 | 描述 |

|---|---|

|

| 使用基于 一致哈希的算法。当禁用服务器提示时,默认选择。 这种实现始终将密钥分配给每个缓存中的同一节点,只要集群是对称的。换句话说,所有缓存在所有节点上运行。这种实施确实有一些负点,负载分布稍微不均匀。它还比加入或离开更严格要求更多片段。 |

|

|

等同于 |

|

|

实现比 |

|

|

等同于 |

|

| 用于内部实施复制缓存。您不应该在分布式缓存中显式选择此算法。 |

哈希配置

您可以配置 ConsistentHashFactory 实现,包括自定义的带有嵌入式缓存。

XML

<distributed-cache name="distributedCache"

owners="2"

segments="100"

capacity-factor="2" />

ConfigurationBuilder

Configuration c = new ConfigurationBuilder()

.clustering()

.cacheMode(CacheMode.DIST_SYNC)

.hash()

.numOwners(2)

.numSegments(100)

.capacityFactor(2)

.build();

其他资源

2.2.3. 容量因素

容量因素根据集群中每个节点的可用资源分配片段数量。

节点的容量因素适用于该节点是主所有者和备份所有者的片段。换句话说,容量因素指定节点与集群中的其他节点相比的总容量。

默认值为 1,这意味着集群中的所有节点都有相等的容量,Data Grid 为集群中的所有节点分配相同的片段数量。

但是,如果节点有不同数量的可用内存,您可以配置容量因素,以便 Data Grid 哈希算法为每个节点分配大量按其容量权重的片段。

容量因素配置的值必须是正数,可以是 1.5 所示的比例。您还可以配置容量因数 0, 但建议临时加入集群的节点,应该改为使用零容量配置。

2.2.3.1. 零容量节点

您可以为每个缓存、用户定义的缓存和内部缓存配置容量因子为 0 的节点。在定义零容量节点时,该节点不会保存任何数据。

零容量节点配置

XML

<infinispan> <cache-container zero-capacity-node="true" /> </infinispan>

JSON

{

"infinispan" : {

"cache-container" : {

"zero-capacity-node" : "true"

}

}

}

YAML

infinispan:

cacheContainer:

zeroCapacityNode: "true"

ConfigurationBuilder

new GlobalConfigurationBuilder().zeroCapacityNode(true);

2.2.4. 一级(L1)缓存

Data Grid 节点会在从集群中的另一节点检索条目时创建本地副本。L1 缓存避免在主所有者节点上重复查找条目并提高性能。

下图演示了 L1 缓存的工作方式:

图 2.4. L1 缓存

在 "L1 缓存"图中:

-

客户端调用

cache.get ()来读取集群中另一个节点是主所有者的条目。 - 原始器节点将读取操作转发到主所有者。

- 主所有者返回键/值条目。

- 原始器节点会创建一个本地副本。

-

后续的

cache.get ()调用会返回本地条目,而不是转发到主所有者。

L1 缓存性能

启用 L1 提高了读取操作的性能,但需要主所有者节点在修改条目时广播失效消息。这样可确保 Data Grid 在集群中删除任何过时的副本。但是,这也降低了写操作的性能并增加内存用量,从而减少缓存的整体容量。

与任何其他缓存条目一样,Data Grid 驱除和过期本地副本或 L1 条目。

L1 缓存配置

XML

<distributed-cache l1-lifespan="5000"

l1-cleanup-interval="60000">

</distributed-cache>

JSON

{

"distributed-cache": {

"l1-lifespan": "5000",

"l1-cleanup-interval": "60000"

}

}

YAML

distributedCache: l1Lifespan: "5000" l1-cleanup-interval: "60000"

ConfigurationBuilder

ConfigurationBuilder builder = new ConfigurationBuilder();

builder.clustering().cacheMode(CacheMode.DIST_SYNC)

.l1()

.lifespan(5000, TimeUnit.MILLISECONDS)

.cleanupTaskFrequency(60000, TimeUnit.MILLISECONDS);

2.2.5. 服务器提示

服务器提示通过尽可能在多个服务器、机架和数据中心中复制条目来提高分布式缓存中数据的可用性。

服务器提示仅适用于分布式缓存。

当 Data Grid 分发您的数据的副本时,它遵循优先级顺序:site、rack、machine 和 node。所有配置属性都是可选的。例如,当您只指定机架 ID 时,Data Grid 会将副本分布到不同的机架和节点上。

如果缓存的片段数量过低,服务器提示可能会影响集群重新平衡操作。

多个数据中心中的集群的替代方法是跨站点复制。

服务器提示配置

XML

<cache-container>

<transport cluster="MyCluster"

machine="LinuxServer01"

rack="Rack01"

site="US-WestCoast"/>

</cache-container>

JSON

{

"infinispan" : {

"cache-container" : {

"transport" : {

"cluster" : "MyCluster",

"machine" : "LinuxServer01",

"rack" : "Rack01",

"site" : "US-WestCoast"

}

}

}

}

YAML

cacheContainer:

transport:

cluster: "MyCluster"

machine: "LinuxServer01"

rack: "Rack01"

site: "US-WestCoast"

GlobalConfigurationBuilder

GlobalConfigurationBuilder global = GlobalConfigurationBuilder.defaultClusteredBuilder()

.transport()

.clusterName("MyCluster")

.machineId("LinuxServer01")

.rackId("Rack01")

.siteId("US-WestCoast");

2.2.6. 关键关联性服务

在分布式缓存中,使用不透明算法将密钥分配给节点列表。无法反转计算并生成映射到特定节点的密钥。但是,Data Grid 可以生成一系列(pseudo-) random 键,查看其主所有者,并在需要关键映射到特定节点时将其移入应用程序。

以下代码片段演示了如何获取和使用对此服务的引用。

// 1. Obtain a reference to a cache

Cache cache = ...

Address address = cache.getCacheManager().getAddress();

// 2. Create the affinity service

KeyAffinityService keyAffinityService = KeyAffinityServiceFactory.newLocalKeyAffinityService(

cache,

new RndKeyGenerator(),

Executors.newSingleThreadExecutor(),

100);

// 3. Obtain a key for which the local node is the primary owner

Object localKey = keyAffinityService.getKeyForAddress(address);

// 4. Insert the key in the cache

cache.put(localKey, "yourValue");服务在第 2 步启动:此时,它使用提供的 Executor 生成和队列密钥。在第 3 步,我们从服务获得密钥,在第 4 步中使用该密钥。

生命周期

KeyAffinityService 扩展 生命周期,它允许停止和(重新)启动它:

public interface Lifecycle {

void start();

void stop();

}

服务通过 KeyAffinityServiceFactory 实例化。所有工厂方法都有一个 Executor 参数,用于异步密钥生成(因此它不会在调用者的线程中发生)。用户负责处理此可执行文件的关闭 。

启动后,KeyAffinityService 需要被显式停止。这会停止后台密钥生成,并释放其他保存的资源。

在 KeyAffinityService 停止它的唯一情况下,当它被注册的缓存管理器被关闭时。

拓扑更改

当缓存拓扑更改时,KeyAffinityService 生成的密钥的所有权可能会改变。key affinity 服务跟踪这些拓扑更改,且不会返回当前映射到不同节点的键,但它不会对之前生成的密钥进行任何操作。

因此,应用程序应该只将 KeyAffinityService 视为优化,它们不应该依赖生成的密钥的位置来获得正确的。

特别是,应用程序不应依赖 KeyAffinityService 生成的密钥,以便始终位于同一地址。密钥共存仅由 Grouping API 提供。

2.2.7. Grouping API

与 Key affinity 服务补充,分组 API 允许您在同一节点上并置一组条目,但不能选择实际节点。

默认情况下,使用密钥的 hashCode () 计算密钥的片段。如果您使用 Grouping API,Data Grid 将计算组的网段,并将其用作密钥的网段。

使用 Grouping API 时,务必要确保每个节点仍然可以计算每个密钥的所有者,而无需联系其他节点。因此,无法手动指定组。组可以刻录到条目(由密钥类生成)或 extrinsic (由外部函数生成)。

要使用 Grouping API,您必须启用组。

Configuration c = new ConfigurationBuilder() .clustering().hash().groups().enabled() .build();

<distributed-cache> <groups enabled="true"/> </distributed-cache>

如果您有关键类的控制(您可以更改类定义,它不是一个不可修改的库的一部分),我们建议使用一个内部组。内部组通过向方法添加 @Group 注释来指定,例如:

class User {

...

String office;

...

public int hashCode() {

// Defines the hash for the key, normally used to determine location

...

}

// Override the location by specifying a group

// All keys in the same group end up with the same owners

@Group

public String getOffice() {

return office;

}

}

}

group 方法必须返回 String

如果您没有对密钥类的控制权,或者组的确定是关键类的正面问题,我们建议使用 extrinsic 组。通过实施 Grouper 接口来指定 extrinsic 组。

public interface Grouper<T> {

String computeGroup(T key, String group);

Class<T> getKeyType();

}

如果为同一密钥类型配置了多个 Grouper 类,则会调用它们的所有类,接收上一个密钥计算的值。如果密钥类也具有 @Group 注释,则第一个 组 将接收由注释方法计算的组。这允许您在使用 内部组时对组进行更大的控制。

Grouper 实现示例

public class KXGrouper implements Grouper<String> {

// The pattern requires a String key, of length 2, where the first character is

// "k" and the second character is a digit. We take that digit, and perform

// modular arithmetic on it to assign it to group "0" or group "1".

private static Pattern kPattern = Pattern.compile("(^k)(<a>\\d</a>)$");

public String computeGroup(String key, String group) {

Matcher matcher = kPattern.matcher(key);

if (matcher.matches()) {

String g = Integer.parseInt(matcher.group(2)) % 2 + "";

return g;

} else {

return null;

}

}

public Class<String> getKeyType() {

return String.class;

}

}

组群 实现必须在缓存配置中显式注册。如果您要以编程方式配置 Data Grid:

Configuration c = new ConfigurationBuilder() .clustering().hash().groups().enabled().addGrouper(new KXGrouper()) .build();

或者,如果您使用 XML:

<distributed-cache>

<groups enabled="true">

<grouper class="com.example.KXGrouper" />

</groups>

</distributed-cache>高级 API

AdvancedCache 有两个特定于组的方法:

-

getGroup (groupName)检索属于组的所有密钥。 -

removeGroup (groupName)会删除属于组的所有密钥。

两种方法会迭代整个数据容器和存储(如果存在),因此当缓存包含大量小组时,它们可能会较慢。

2.3. 无效的缓存

Data Grid 中的无效缓存模式旨在优化对共享持久数据存储执行大量读取操作的系统。您可以使用 invalidation 模式来减少在状态发生变化时数据库写入的数量。

对于 Data Grid 远程部署,无效缓存模式已弃用。使用带有存储在共享缓存存储中的嵌入式缓存模式的 invalidation 缓存模式。

只有在您具有持久性数据存储(如数据库)且仅在 read-heavy 系统中使用 Data Grid 优化时,无效缓存模式才会生效。

当为无效配置缓存时,缓存中的每个数据更改都会触发对集群中其他缓存的消息,通知它们的数据现在已过时,应该从内存中删除。validation 消息从其他节点的内存中删除过时的值。与复制整个值相比,消息非常小,并且集群中的其他缓存会以 lazy 方法查找修改的数据,仅在需要时才会查找修改的数据。对共享存储的更新通常由用户应用程序代码或 Hibernate 处理。

图 2.5. 无效的缓存

有时,应用会从外部存储中读取值,并希望将其写入本地缓存,而无需将其从其他节点中删除。要做到这一点,它必须调用 Cache.putForExternalRead (key, value) 而不是 Cache.put (key, value)。

invalidation 模式仅适用于所有节点可以访问同一数据的共享存储。在没有持久性存储的情况下使用 invalidation 模式是不切实际的,因为更新的值需要从共享存储中读取,以实现跨节点的一致性。

切勿将无效模式与本地非共享缓存存储一起使用。invalidation 消息不会删除本地存储中的条目,一些节点会保持过时的值。

无效的缓存也可以使用特殊的缓存加载程序 ClusterLoader 进行配置。启用 ClusterLoader 时,在本地节点上找不到密钥的读取操作将首先从所有其他节点请求,并将其保存在本地内存中。这可能会导致存储过时的值,因此只有在您对过时的值具有高容错时才使用它。

同步或异步复制

当同步时,写入操作块直到集群中的所有节点都被驱除了 stale 值。当异步时,原始器会广播失效消息,但不会等待响应。这意味着,其他节点仍然会在原始器的写入完成后看到一个过时的值。

Transactions

事务可用于批处理失效消息。事务在主所有者上获取密钥锁定。

使用 pesimistic locking 时,每个写入都会触发锁定消息,该消息会广播到所有节点。在事务提交过程中,原始器广播一个单阶段准备消息(可选)准备消息(可选)使所有受影响的密钥和释放锁无效。

使用最佳锁定时,源器广播准备消息、提交消息和解锁消息(可选)。第一阶段准备或解锁消息为 fire-and-forget,最后一条消息始终释放锁。

2.4. 异步复制

所有集群缓存模式都可以配置为在 < replicated-cache/>、< 使用与 distributed-cache> 或 < invalidation-cache/& gt; 元素中mode="ASYNC" 属性的异步通信。

通过异步通信,原始器节点不会收到来自其他节点有关操作状态的任何确认,因此无法检查它是否在其他节点上成功。

我们不推荐一般推荐异步通信,因为它们可能会导致数据中的不一致,并且结果很难考虑。然而,有时速度比一致性更重要,而选项则适用于这些情况。

Asynchronous API

Asynchronous API 允许您使用同步通信,但不阻止用户线程。

存在一个注意事项:异步操作不会保留程序顺序。如果线程调用 cache.putAsync (k, v1); cache.putAsync (k, v2),则 k 的最终值可以是 v1 或 v2。与使用异步通信相比,最终的值不能在一个节点上是 v1,而 v2 则位于另一个节点上。

2.4.1. 使用异步复制返回值

由于 缓存 接口扩展了 java.util.Map,因此默认情况下写入方法(如 put (key, value) 和 remove (key) 会返回之前的值。

在某些情况下,返回的值可能不正确:

-

将

AdvancedCache.withFlags ()与Flag.IGNORE_RETURN_VALUE,Flag.SKIP_REMOTE_LOOKUP, 或Flag.SKIP_CACHE_LOAD. -

当使用

不可靠的-return-values="true" 配置缓存时。 - 使用异步通信时。

- 当同一键有多个并发写入时,缓存拓扑会改变。拓扑更改将使 Data Grid 重试写操作,而重试操作的返回值并不可靠。

事务缓存在 3 和 4 情况下返回正确的值。但是,事务性缓存在分布式模式下也有一个 gotcha:,read-committed 的隔离级别被实施为可重复读取。这意味着,"double-checked locking"示例无法正常工作:

Cache cache = ...

TransactionManager tm = ...

tm.begin();

try {

Integer v1 = cache.get(k);

// Increment the value

Integer v2 = cache.put(k, v1 + 1);

if (Objects.equals(v1, v2) {

// success

} else {

// retry

}

} finally {

tm.commit();

}

实现这一点的正确方法是使用 cache.getAdvancedCache ().withFlags (Flag.FORCE_WRITE_LOCK).get (k)。

在具有最佳锁定的缓存中,写入也可以返回过时的之前值。编写偏移检查可以避免过时的之前值。

2.5. 配置初始集群大小

Data Grid 动态处理集群拓扑更改。这意味着,在 Data Grid 初始化缓存前,节点不需要等待其他节点加入集群。

如果应用程序在缓存启动前需要集群中的特定数量的节点,您可以将初始集群大小配置为传输的一部分。

流程

- 打开 Data Grid 配置以进行编辑。

-

在缓存以

initial-cluster-size属性或initialClusterSize ()方法开头前,设置所需的最少节点数。 -

设置 timeout,以毫秒为单位,之后缓存管理器不会以

initial-cluster-timeout属性或initialClusterTimeout ()方法开头。 - 保存并关闭您的 Data Grid 配置。

初始集群大小配置

XML

<infinispan>

<cache-container>

<transport initial-cluster-size="4"

initial-cluster-timeout="30000" />

</cache-container>

</infinispan>

JSON

{

"infinispan" : {

"cache-container" : {

"transport" : {

"initial-cluster-size" : "4",

"initial-cluster-timeout" : "30000"

}

}

}

}

YAML

infinispan:

cacheContainer:

transport:

initialClusterSize: "4"

initialClusterTimeout: "30000"

ConfigurationBuilder

GlobalConfiguration global = GlobalConfigurationBuilder.defaultClusteredBuilder() .transport() .initialClusterSize(4) .initialClusterTimeout(30000, TimeUnit.MILLISECONDS);

第 3 章 Data Grid 缓存配置

缓存配置控制 Data Grid 如何存储您的数据。

作为缓存配置的一部分,您可以声明您要使用的缓存模式。例如,您可以将 Data Grid 集群配置为使用复制缓存或分布式缓存。

您的配置还定义了缓存的特性并启用您要在处理数据时使用的 Data Grid 功能。例如,您可以配置 Data Grid 对缓存中的条目进行编码的方式,无论是同步还是在节点间异步发生复制请求,如果条目是 mortal 或 immortal,等等。

3.1. 声明性缓存配置

您可以根据 Data Grid 模式,以 XML、JSON 和 YAML 格式配置缓存。

与编程配置相比,声明性缓存配置有以下优点:

- 可移植性

-

在独立文件中定义每个配置,可用于创建嵌入和远程缓存。

您还可以使用声明配置,通过 Data Grid Operator 为 OpenShift 上运行的集群创建缓存。 - 简单性

-

保留独立于编程语言的标记语言。

例如,创建远程缓存通常最好不要直接向 Java 代码添加复杂的 XML。

Data Grid 服务器配置扩展了 infinispan.xml,使其包含集群传输机制、安全域和端点配置。如果您将缓存声明为 Data Grid Server 配置的一部分,您应该使用管理工具,如 Ansible 或 Chef,使其在集群中同步。

要在 Data Grid 集群中动态同步远程缓存,请在运行时创建它们。

3.1.1. 缓存配置

您可以使用 XML、JSON 和 YAML 格式创建声明性缓存配置。

所有声明缓存都必须符合 Data Grid 模式。JSON 格式的配置必须遵循 XML 配置的结构,元素对应于字段和属性。

Data Grid 将字符限制为最多 255 个缓存名称或缓存模板名称。如果您超过这个字符限制,Data Grid 会抛出异常。编写 succinct 缓存名称和缓存模板名称。

文件系统可能会为文件名长度设置限制,因此请确保缓存的名称不超过这个限制。如果缓存名称超过文件系统的命名限制,则对该缓存的一般操作或初始操作可能会失败。写入 succinct 文件名。

分布式缓存

XML

<distributed-cache owners="2"

segments="256"

capacity-factor="1.0"

l1-lifespan="5000"

mode="SYNC"

statistics="true">

<encoding media-type="application/x-protostream"/>

<locking isolation="REPEATABLE_READ"/>

<transaction mode="FULL_XA"

locking="OPTIMISTIC"/>

<expiration lifespan="5000"

max-idle="1000" />

<memory max-count="1000000"

when-full="REMOVE"/>

<indexing enabled="true"

storage="local-heap">

<index-reader refresh-interval="1000"/>

<indexed-entities>

<indexed-entity>org.infinispan.Person</indexed-entity>

</indexed-entities>

</indexing>

<partition-handling when-split="ALLOW_READ_WRITES"

merge-policy="PREFERRED_NON_NULL"/>

<persistence passivation="false">

<!-- Persistent storage configuration. -->

</persistence>

</distributed-cache>

JSON

{

"distributed-cache": {

"mode": "SYNC",

"owners": "2",

"segments": "256",

"capacity-factor": "1.0",

"l1-lifespan": "5000",

"statistics": "true",

"encoding": {

"media-type": "application/x-protostream"

},

"locking": {

"isolation": "REPEATABLE_READ"

},

"transaction": {

"mode": "FULL_XA",

"locking": "OPTIMISTIC"

},

"expiration" : {

"lifespan" : "5000",

"max-idle" : "1000"

},

"memory": {

"max-count": "1000000",

"when-full": "REMOVE"

},

"indexing" : {

"enabled" : true,

"storage" : "local-heap",

"index-reader" : {

"refresh-interval" : "1000"

},

"indexed-entities": [

"org.infinispan.Person"

]

},

"partition-handling" : {

"when-split" : "ALLOW_READ_WRITES",

"merge-policy" : "PREFERRED_NON_NULL"

},

"persistence" : {

"passivation" : false

}

}

}

YAML

distributedCache:

mode: "SYNC"

owners: "2"

segments: "256"

capacityFactor: "1.0"

l1Lifespan: "5000"

statistics: "true"

encoding:

mediaType: "application/x-protostream"

locking:

isolation: "REPEATABLE_READ"

transaction:

mode: "FULL_XA"

locking: "OPTIMISTIC"

expiration:

lifespan: "5000"

maxIdle: "1000"

memory:

maxCount: "1000000"

whenFull: "REMOVE"

indexing:

enabled: "true"

storage: "local-heap"

indexReader:

refreshInterval: "1000"

indexedEntities:

- "org.infinispan.Person"

partitionHandling:

whenSplit: "ALLOW_READ_WRITES"

mergePolicy: "PREFERRED_NON_NULL"

persistence:

passivation: "false"

# Persistent storage configuration.

复制的缓存

XML

<replicated-cache segments="256"

mode="SYNC"

statistics="true">

<encoding media-type="application/x-protostream"/>

<locking isolation="REPEATABLE_READ"/>

<transaction mode="FULL_XA"

locking="OPTIMISTIC"/>

<expiration lifespan="5000"

max-idle="1000" />

<memory max-count="1000000"

when-full="REMOVE"/>

<indexing enabled="true"

storage="local-heap">

<index-reader refresh-interval="1000"/>

<indexed-entities>

<indexed-entity>org.infinispan.Person</indexed-entity>

</indexed-entities>

</indexing>

<partition-handling when-split="ALLOW_READ_WRITES"

merge-policy="PREFERRED_NON_NULL"/>

<persistence passivation="false">

<!-- Persistent storage configuration. -->

</persistence>

</replicated-cache>

JSON

{

"replicated-cache": {

"mode": "SYNC",

"segments": "256",

"statistics": "true",

"encoding": {

"media-type": "application/x-protostream"

},

"locking": {

"isolation": "REPEATABLE_READ"

},

"transaction": {

"mode": "FULL_XA",

"locking": "OPTIMISTIC"

},

"expiration" : {

"lifespan" : "5000",

"max-idle" : "1000"

},

"memory": {

"max-count": "1000000",

"when-full": "REMOVE"

},

"indexing" : {

"enabled" : true,

"storage" : "local-heap",

"index-reader" : {

"refresh-interval" : "1000"

},

"indexed-entities": [

"org.infinispan.Person"

]

},

"partition-handling" : {

"when-split" : "ALLOW_READ_WRITES",

"merge-policy" : "PREFERRED_NON_NULL"

},

"persistence" : {

"passivation" : false

}

}

}

YAML

replicatedCache:

mode: "SYNC"

segments: "256"

statistics: "true"

encoding:

mediaType: "application/x-protostream"

locking:

isolation: "REPEATABLE_READ"

transaction:

mode: "FULL_XA"

locking: "OPTIMISTIC"

expiration:

lifespan: "5000"

maxIdle: "1000"

memory:

maxCount: "1000000"

whenFull: "REMOVE"

indexing:

enabled: "true"

storage: "local-heap"

indexReader:

refreshInterval: "1000"

indexedEntities:

- "org.infinispan.Person"

partitionHandling:

whenSplit: "ALLOW_READ_WRITES"

mergePolicy: "PREFERRED_NON_NULL"

persistence:

passivation: "false"

# Persistent storage configuration.

多个缓存

XML

<infinispan

xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xsi:schemaLocation="urn:infinispan:config:15.0 https://infinispan.org/schemas/infinispan-config-15.0.xsd

urn:infinispan:server:15.0 https://infinispan.org/schemas/infinispan-server-15.0.xsd"

xmlns="urn:infinispan:config:15.0"

xmlns:server="urn:infinispan:server:15.0">

<cache-container name="default"

statistics="true">

<distributed-cache name="mycacheone"

mode="ASYNC"

statistics="true">

<encoding media-type="application/x-protostream"/>

<expiration lifespan="300000"/>

<memory max-size="400MB"

when-full="REMOVE"/>

</distributed-cache>

<distributed-cache name="mycachetwo"

mode="SYNC"

statistics="true">

<encoding media-type="application/x-protostream"/>

<expiration lifespan="300000"/>

<memory max-size="400MB"

when-full="REMOVE"/>

</distributed-cache>

</cache-container>

</infinispan>

JSON

{

"infinispan" : {

"cache-container" : {

"name" : "default",

"statistics" : "true",

"caches" : {

"mycacheone" : {

"distributed-cache" : {

"mode": "ASYNC",

"statistics": "true",

"encoding": {

"media-type": "application/x-protostream"

},

"expiration" : {

"lifespan" : "300000"

},

"memory": {

"max-size": "400MB",

"when-full": "REMOVE"

}

}

},

"mycachetwo" : {

"distributed-cache" : {

"mode": "SYNC",

"statistics": "true",

"encoding": {

"media-type": "application/x-protostream"

},

"expiration" : {

"lifespan" : "300000"

},

"memory": {

"max-size": "400MB",

"when-full": "REMOVE"

}

}

}

}

}

}

}

YAML

infinispan:

cacheContainer:

name: "default"

statistics: "true"

caches:

mycacheone:

distributedCache:

mode: "ASYNC"

statistics: "true"

encoding:

mediaType: "application/x-protostream"

expiration:

lifespan: "300000"

memory:

maxSize: "400MB"

whenFull: "REMOVE"

mycachetwo:

distributedCache:

mode: "SYNC"

statistics: "true"

encoding:

mediaType: "application/x-protostream"

expiration:

lifespan: "300000"

memory:

maxSize: "400MB"

whenFull: "REMOVE"

3.2. 添加缓存模板

Data Grid 模式包括可用于创建模板的 *-cache-configuration 元素。然后,您可以根据需要创建缓存,多次使用相同的配置。

流程

- 打开 Data Grid 配置以进行编辑。

-

使用适当的

*-cache-configuration元素或对象将缓存配置添加到 Cache Manager。 - 保存并关闭您的 Data Grid 配置。

缓存模板示例

XML

<infinispan>

<cache-container>

<distributed-cache-configuration name="my-dist-template"

mode="SYNC"

statistics="true">

<encoding media-type="application/x-protostream"/>

<memory max-count="1000000"

when-full="REMOVE"/>

<expiration lifespan="5000"

max-idle="1000"/>

</distributed-cache-configuration>

</cache-container>

</infinispan>

JSON

{

"infinispan" : {

"cache-container" : {

"distributed-cache-configuration" : {

"name" : "my-dist-template",

"mode": "SYNC",

"statistics": "true",

"encoding": {

"media-type": "application/x-protostream"

},

"expiration" : {

"lifespan" : "5000",

"max-idle" : "1000"

},

"memory": {

"max-count": "1000000",

"when-full": "REMOVE"

}

}

}

}

}

YAML

infinispan:

cacheContainer:

distributedCacheConfiguration:

name: "my-dist-template"

mode: "SYNC"

statistics: "true"

encoding:

mediaType: "application/x-protostream"

expiration:

lifespan: "5000"

maxIdle: "1000"

memory:

maxCount: "1000000"

whenFull: "REMOVE"

3.2.1. 从模板创建缓存

从配置模板创建缓存。

远程缓存的模板可从 Data Grid 控制台中的 Cache templates 菜单获得。

先决条件

- 将至少一个缓存模板添加到缓存管理器。

流程

- 打开 Data Grid 配置以进行编辑。

-

指定缓存使用

配置属性或字段继承的模板。 - 保存并关闭您的 Data Grid 配置。

从模板继承的缓存配置

XML

<distributed-cache configuration="my-dist-template" />

JSON

{

"distributed-cache": {

"configuration": "my-dist-template"

}

}

YAML

distributedCache: configuration: "my-dist-template"

3.2.2. 缓存模板继承

缓存配置模板可以从其他模板继承,以扩展和覆盖设置。

缓存模板继承是分层的。要使子配置模板从父项继承,您必须在父模板后面包含它。

另外,对于具有多个值的元素,模板继承性是添加的。从另一个模板继承的缓存会合并该模板中的值,这可能会覆盖属性。

模板继承示例

XML

<infinispan>

<cache-container>

<distributed-cache-configuration name="base-template">

<expiration lifespan="5000"/>

</distributed-cache-configuration>

<distributed-cache-configuration name="extended-template"

configuration="base-template">

<encoding media-type="application/x-protostream"/>

<expiration lifespan="10000"

max-idle="1000"/>

</distributed-cache-configuration>

</cache-container>

</infinispan>

JSON

{

"infinispan" : {

"cache-container" : {

"caches" : {

"base-template" : {

"distributed-cache-configuration" : {

"expiration" : {

"lifespan" : "5000"

}

}

},

"extended-template" : {

"distributed-cache-configuration" : {

"configuration" : "base-template",

"encoding": {

"media-type": "application/x-protostream"

},

"expiration" : {

"lifespan" : "10000",

"max-idle" : "1000"

}

}

}

}

}

}

}

YAML

infinispan:

cacheContainer:

caches:

base-template:

distributedCacheConfiguration:

expiration:

lifespan: "5000"

extended-template:

distributedCacheConfiguration:

configuration: "base-template"

encoding:

mediaType: "application/x-protostream"

expiration:

lifespan: "10000"

maxIdle: "1000"

3.2.3. 缓存模板通配符

您可以将通配符添加到缓存模板名称。如果您创建名称与通配符匹配的缓存,Data Grid 应用配置模板。

如果缓存名称与多个通配符匹配,则数据网格会抛出异常。

模板通配符示例

XML

<infinispan>

<cache-container>

<distributed-cache-configuration name="async-dist-cache-*"

mode="ASYNC"

statistics="true">

<encoding media-type="application/x-protostream"/>

</distributed-cache-configuration>

</cache-container>

</infinispan>

JSON

{

"infinispan" : {

"cache-container" : {

"distributed-cache-configuration" : {

"name" : "async-dist-cache-*",

"mode": "ASYNC",

"statistics": "true",

"encoding": {

"media-type": "application/x-protostream"

}

}

}

}

}

YAML

infinispan:

cacheContainer:

distributedCacheConfiguration:

name: "async-dist-cache-*"

mode: "ASYNC"

statistics: "true"

encoding:

mediaType: "application/x-protostream"

使用前面的示例,如果您创建一个名为 "async-dist-cache-prod" 的缓存,则 Data Grid 会使用 async-dist-cache reasonable 模板的配置。

3.2.4. 从多个 XML 文件缓存模板

将缓存配置模板分成多个 XML 文件,以获得细致的灵活性,并通过 XML 包括(XInclude)引用它们。

Data Grid 为 XInclude 规格提供最少的支持。这意味着您无法使用 xpointer 属性、xi:fallback 元素、文本处理或内容协商。

您还必须将 xmlns:xi="http://www.w3.org/2001/XInclude" 命名空间添加到 infinispan.xml 才能使用 XInclude。

Xinclude 缓存模板

<infinispan xmlns:xi="http://www.w3.org/2001/XInclude">

<cache-container default-cache="cache-1">

<!-- References files that contain cache configuration templates. -->

<xi:include href="distributed-cache-template.xml" />

<xi:include href="replicated-cache-template.xml" />

</cache-container>

</infinispan>

Data Grid 还提供了一个 infinispan-config-fragment-15.0.xsd 模式,供您用于配置片段。

配置片段模式

<local-cache xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xsi:schemaLocation="urn:infinispan:config:15.0 https://infinispan.org/schemas/infinispan-config-fragment-15.0.xsd"

xmlns="urn:infinispan:config:15.0"

name="mycache"/>

其他资源

3.3. 缓存别名

为缓存添加别名以使用不同名称访问它们。

缓存配置的 alias 属性在运行时是 updatable。将别名重新分配给不同的缓存,以快速切换缓存内容。

XML

<distributed-cache name="acache" aliases="0 anothername"/>

JSON

{

"distributed-cache": {

"aliases": ["0", "anothername"]

}

}

YAML

distributedCache:

aliases:

- "0"

- "anothername"

3.4. 创建远程缓存

当您在运行时创建远程缓存时,Data Grid 服务器会在集群中同步您的配置,以便所有节点都有副本。因此,您应该始终使用以下机制动态创建远程缓存:

- Data Grid 控制台

- Data Grid 命令行界面(CLI)

- 热 Rod 或 HTTP 客户端

3.4.1. 默认缓存管理器

Data Grid Server 提供了一个默认的缓存管理器,用于控制远程缓存的生命周期。启动 Data Grid 服务器会自动实例化缓存管理器,以便您可以创建和删除远程缓存和其他资源,如 Protobuf 模式。

启动 Data Grid 服务器并添加用户凭证后,您可以查看缓存管理器的详情,并从 Data Grid 控制台获取集群信息。

-

在任何浏览器中打开

127.0.0.1:11222。

您还可以通过命令行界面(CLI)或 REST API 获取有关缓存管理器的信息:

- CLI

在 default 容器中运行

describe命令。[//containers/default]> describe

- REST

-

在任何浏览器中打开

127.0.0.1:11222/rest/v2/container/。

默认缓存管理器配置

XML

<infinispan>

<!-- Creates a Cache Manager named "default" and enables metrics. -->

<cache-container name="default"

statistics="true">

<!-- Adds cluster transport that uses the default JGroups TCP stack. -->

<transport cluster="${infinispan.cluster.name:cluster}"

stack="${infinispan.cluster.stack:tcp}"

node-name="${infinispan.node.name:}"/>

<!-- Requires user permission to access caches and perform operations. -->

<security>

<authorization/>

</security>

</cache-container>

</infinispan>

JSON

{

"infinispan" : {

"jgroups" : {

"transport" : "org.infinispan.remoting.transport.jgroups.JGroupsTransport"

},

"cache-container" : {

"name" : "default",

"statistics" : "true",

"transport" : {

"cluster" : "cluster",

"node-name" : "",

"stack" : "tcp"

},

"security" : {

"authorization" : {}

}

}

}

}

YAML

infinispan:

jgroups:

transport: "org.infinispan.remoting.transport.jgroups.JGroupsTransport"

cacheContainer:

name: "default"

statistics: "true"

transport:

cluster: "cluster"

nodeName: ""

stack: "tcp"

security:

authorization: ~

3.4.2. 使用 Data Grid 控制台创建缓存

使用 Data Grid 控制台从任何 Web 浏览器使用直观的可视化界面创建远程缓存。

先决条件

-

创建具有

admin权限的 Data Grid 用户。 - 至少启动一个 Data Grid 服务器实例。

- 具有 Data Grid 缓存配置。

流程

-

在任意浏览器中打开

127.0.0.1:11222/console/。 - 选择 Create Cache 并按照步骤操作,作为 Data Grid Console 指南。

3.4.3. 使用 Data Grid CLI 创建远程缓存

使用 Data Grid 命令行界面(CLI)在 Data Grid Server 中添加远程缓存。

先决条件

-

创建具有

admin权限的 Data Grid 用户。 - 至少启动一个 Data Grid 服务器实例。

- 具有 Data Grid 缓存配置。

流程

启动 CLI。

bin/cli.sh

-

运行

connect命令,并在提示时输入您的用户名和密码。 使用

create cache命令创建远程缓存。例如,从名为

mycache.xml的文件创建一个名为 "mycache" 的缓存,如下所示:create cache --file=mycache.xml mycache

验证

使用

ls命令列出所有远程缓存。ls caches mycache

使用

describe命令查看缓存配置。describe caches/mycache

3.4.4. 从 Hot Rod 客户端创建远程缓存

使用 Data Grid Hot Rod API 从 Java、C++、.NET/C#、JS 客户端等在 Data Grid Server 上创建远程缓存。

此流程演示了如何使用 Hot Rod Java 客户端在首次访问时创建远程缓存。您可以在 Data Grid Tutorials 中找到其他 Hot Rod 客户端的代码示例。

先决条件

-

创建具有

admin权限的 Data Grid 用户。 - 至少启动一个 Data Grid 服务器实例。

- 具有 Data Grid 缓存配置。

流程

-

调用

remoteCache ()方法,作为ConfigurationBuilder的一部分。 -

在 classpath 上的

hotrod-client.properties文件中设置configuration或configuration_uri属性。

ConfigurationBuilder

File file = new File("path/to/infinispan.xml")

ConfigurationBuilder builder = new ConfigurationBuilder();

builder.remoteCache("another-cache")

.configuration("<distributed-cache name=\"another-cache\"/>");

builder.remoteCache("my.other.cache")

.configurationURI(file.toURI());

hotrod-client.properties

infinispan.client.hotrod.cache.another-cache.configuration=<distributed-cache name=\"another-cache\"/> infinispan.client.hotrod.cache.[my.other.cache].configuration_uri=file:///path/to/infinispan.xml

如果远程缓存的名称包含 . 字符,则必须在使用 hotrod-client.properties 文件时将其放在方括号中。

3.4.5. 使用 REST API 创建远程缓存

使用 Data Grid REST API 从任何合适的 HTTP 客户端在 Data Grid Server 上创建远程缓存。

先决条件

-

创建具有

admin权限的 Data Grid 用户。 - 至少启动一个 Data Grid 服务器实例。

- 具有 Data Grid 缓存配置。

流程

-

使用有效负载中的缓存配置调用

POST请求到/rest/v2/caches/<cache_name>。

其他资源

3.5. 创建嵌入式缓存

Data Grid 提供了一个 EmbeddedCacheManager API,可让您以编程方式控制缓存管理器和嵌入式缓存生命周期。

3.5.1. 在项目中添加 Data Grid

将 Data Grid 添加到项目,以便在您的应用程序中创建嵌入的缓存。

先决条件

- 配置项目以从 Maven 存储库获取数据网格工件。

流程

-

将

infinispan-core工件作为依赖项添加到pom.xml中,如下所示:

<dependencies>

<dependency>

<groupId>org.infinispan</groupId>

<artifactId>infinispan-core</artifactId>

</dependency>

</dependencies>3.5.2. 创建和使用嵌入式缓存

Data Grid 提供了一个 GlobalConfigurationBuilder API,用于控制 Cache Manager 和用于配置缓存的 ConfigurationBuilder API。

先决条件

-

将

infinispan-core工件添加为pom.xml中的依赖项。

流程

初始化

CacheManager。注意在创建缓存前,您必须始终调用

cacheManager.start ()方法来初始化CacheManager。默认构造器为您完成此操作,但构建器的超载版本不会为您这样做。缓存管理器也是重量的对象,Data Grid 建议实例化每个 JVM 只有一个实例。

-

使用

ConfigurationBuilderAPI 定义缓存配置。 使用

getCache ()、createCache ()或getOrCreateCache ()方法获取缓存。Data Grid 建议使用

getOrCreateCache ()方法,因为它在所有节点上创建一个缓存或返回现有的缓存。-

如有必要,对缓存使用

PERMANENT标志,以在重启后保留。 -

通过调用

cacheManager.stop ()方法以释放 JVM 资源并正常关闭任何缓存,以停止CacheManager。

// Set up a clustered Cache Manager.

GlobalConfigurationBuilder global = GlobalConfigurationBuilder.defaultClusteredBuilder();

// Initialize the default Cache Manager.

DefaultCacheManager cacheManager = new DefaultCacheManager(global.build());

// Create a distributed cache with synchronous replication.

ConfigurationBuilder builder = new ConfigurationBuilder();

builder.clustering().cacheMode(CacheMode.DIST_SYNC);

// Obtain a volatile cache.

Cache<String, String> cache = cacheManager.administration().withFlags(CacheContainerAdmin.AdminFlag.VOLATILE).getOrCreateCache("myCache", builder.build());

// Stop the Cache Manager.

cacheManager.stop();getCache () 方法

调用 getCache (String) 方法以获取缓存,如下所示:

Cache<String, String> myCache = manager.getCache("myCache");

前面的操作会创建一个名为 myCache 的缓存(如果尚未存在),并返回它。

使用 getCache () 方法仅在您调用方法的节点上创建缓存。换句话说,它会执行一个本地操作,它必须在集群中的每个节点上调用。通常,在多个节点间部署的应用程序会在初始化过程中获取缓存,以确保缓存都是 对称的,并在每个节点上存在。

createCache () 方法

调用 createCache () 方法,以在整个集群中动态创建缓存。

Cache<String, String> myCache = manager.administration().createCache("myCache", "myTemplate");前面的操作还会在随后加入集群的任何节点上自动创建缓存。

默认情况下,您使用 createCache () 方法创建的缓存是临时的。如果整个集群关闭,则缓存重启后不会自动创建。

PERMANENT 标志

使用 PERMANENT 标志来确保缓存可以在重启后保留。

Cache<String, String> myCache = manager.administration().withFlags(AdminFlag.PERMANENT).createCache("myCache", "myTemplate");要使 PERMANENT 标志生效,您必须启用全局状态并设置配置存储提供程序。

有关配置存储供应商的更多信息,请参阅 GlobalStateConfigurationBuilder#configurationStorage ()。

3.5.3. Cache API

Data Grid 提供了一个 Cache 接口,它公开简单的方法来添加、检索和删除条目,包括 JDK 的 ConcurrentMap 接口公开的原子机制。根据所使用的缓存模式,调用这些方法会触发多个事情,甚至可能包括将条目复制到远程节点或从远程节点查找条目,或可能缓存存储。

对于简单使用,使用 Cache API 不应与使用 JDK Map API 不同,因此从基于映射到 Data Grid 的缓存的简单内存缓存迁移应该很简单。

Certain Map 方法的性能一致性

与 Data Grid 一起使用时,在 Map 中公开的某些方法具有一定的性能后果,如 size ()、value ()、keySet () 和 entrySet ()。有关 keySet、value 和 entrySet 的具体方法,请参阅其 Javadoc 了解更多详情。

试图全局执行这些操作会对性能有很大的影响,并成为可扩展性瓶颈。因此,这些方法应该仅用于信息或调试目的。

应注意,在 withFlags () 方法中使用某些标记可以缓解其中的一些问题,请检查每个方法的文档以了解更多详情。

Mortal 和 Immortal Data

除了仅存储条目外,Data Grid 的缓存 API 允许您向数据附加 mortality 信息。例如,只是使用 put (键,值) 会创建一个 immortal 条目,例如,一个存在于缓存中的条目(永久存在),直到它被删除(或逐出内存以防止耗尽内存)。但是,如果您使用 put (key, value, lifespan, timeunit) 将数据放入缓存中,这会创建一个 mortal 条目,即具有固定生命周期的条目,并在该生命周期后过期。

除了 Lifespan 外,Data Grid 还支持 maxIdle 作为额外的指标,以决定到期。可以使用任何 lifespans 或 maxIdles 的组合。

putForExternalRead 操作

Data Grid 的 Cache 类包含不同的"put"操作,称为 putForExternalRead。当 Data Grid 用作在其他位置保留数据的临时缓存时,此操作特别有用。在大量读取场景中,缓存中的竞争不应延迟实时事务,因为缓存应该只是优化,而不是以某种方式获得。

要达到此目的,putForExternalRead () 充当 put 调用,只有在缓存中不存在密钥时才运行,并在另一个线程尝试同时存储同一密钥时失败。在这个特殊情况下,缓存数据是优化系统的方法,而不需要缓存失败会影响到持续的事务,因此为什么以不同的方式处理失败。putForExternalRead () 被视为快速操作,因为无论它是否成功,它都不会等待任何锁定,因此会立即返回到调用者。

要了解如何使用此操作,让我们来看基本的示例。试想一下,个人实例的缓存,每个由 PersonId 的密钥,其数据源自于单独的数据存储中。以下代码显示了在此示例上下文中使用 putForExternalRead 的最常见模式:

// Id of the person to look up, provided by the application

PersonId id = ...;

// Get a reference to the cache where person instances will be stored

Cache<PersonId, Person> cache = ...;

// First, check whether the cache contains the person instance

// associated with with the given id

Person cachedPerson = cache.get(id);

if (cachedPerson == null) {

// The person is not cached yet, so query the data store with the id

Person person = dataStore.lookup(id);

// Cache the person along with the id so that future requests can

// retrieve it from memory rather than going to the data store

cache.putForExternalRead(id, person);

} else {

// The person was found in the cache, so return it to the application

return cachedPerson;

}请注意,putForExternalRead 不应用作使用源自应用程序执行的新 Person 实例更新缓存的机制(例如,来自修改人员地址的事务)。更新缓存的值时,请使用标准 放置 操作,否则可能会出现缓存损坏数据的可能性。

3.5.3.1. AdvancedCache API

除了简单缓存接口外,Data Grid 还提供 AdvancedCache 接口,并提供给扩展作者。AdvancedCache 提供了访问某些内部组件,并应用标志来改变某些缓存方法的默认行为。以下代码片段描述了如何获取 AdvancedCache:

AdvancedCache advancedCache = cache.getAdvancedCache();

3.5.3.1.1. 标记

标志应用到常规缓存方法,以更改某些方法的行为。有关所有可用标志及其效果的列表,请查看 标记 枚举。使用 AdvancedCache.withFlags () 应用标志。此 builder 方法可用于将任意数量的标记应用到缓存调用,例如:

advancedCache.withFlags(Flag.CACHE_MODE_LOCAL, Flag.SKIP_LOCKING)

.withFlags(Flag.FORCE_SYNCHRONOUS)

.put("hello", "world");3.5.3.2. Asynchronous API

除了同步的 API 方法(如 Cache.put ()、Cache.remove () 等)之外,数据网格也有一个异步的非阻塞 API,您可以在其中实现相同的结果。

这些方法的命名方式与阻塞计数器类似,并附加"Async"。 例如,Cache.putAsync ()、Cache.removeAsync () 等。 这些异步对应部分返回一个包含操作实际结果的 CompletableFuture。

例如,在 cache 参数中,在 Cache<String, String>, Cache.put (String key, String value) 返回 String while Cache.putAsync (String key) returns Complet ableFuture<String>。

3.5.3.2.1. 为什么使用这种 API?

非阻塞 API 非常强大,它们提供了所有同步通信保证 - 能够处理通信故障和例外 - 在调用完成后不需要阻止。 这可让您更好地利用系统中的并行性。 例如:

Set<CompletableFuture<?>> futures = new HashSet<>(); futures.add(cache.putAsync(key1, value1)); // does not block futures.add(cache.putAsync(key2, value2)); // does not block futures.add(cache.putAsync(key3, value3)); // does not block // the remote calls for the 3 puts will effectively be executed // in parallel, particularly useful if running in distributed mode // and the 3 keys would typically be pushed to 3 different nodes // in the cluster // check that the puts completed successfully for (CompletableFuture<?> f: futures) f.get();

3.5.3.2.2. 哪些进程实际发生在异步中?

Data Grid 中有 4 个事情,它们被视为典型写入操作的关键路径。这些是成本顺序:

- 网络调用

- Marshalling

- 写入缓存存储(可选)

- 锁定

使用 async 方法将取网络调用和划分出关键路径。 然而,出于各种技术原因,写入缓存存储和获取锁定,但仍然出现在调用者的线程中。

第 4 章 启用并配置 Data Grid 统计和 JMX 监控

网格可以提供缓存管理器和缓存统计信息,以及导出 JMX MBeans。

4.1. 配置 Data Grid 指标

Data Grid 生成与任何监控系统兼容的指标。

- 量表提供值,如写操作或 JVM 正常运行时间的平均纳秒数。

- histograms 提供有关操作执行时间的详细信息,如读取、写入和删除时间。

默认情况下,当启用统计数据时,Data Grid 会生成量表,但您也可以将其配置为生成直方图。

Data Grid 指标在 供应商 范围内提供。与 JVM 相关的指标 在基本 范围内提供。

流程

- 打开 Data Grid 配置以进行编辑。

-

将

metrics元素或对象添加到缓存容器。 -

使用量表属性或字段启用或禁用

量表。 -

使用

histograms属性或字段启用或禁用直方图。 - 保存并关闭您的客户端配置。

指标配置

XML

<infinispan>

<cache-container statistics="true">

<metrics gauges="true"

histograms="true" />

</cache-container>

</infinispan>

JSON

{

"infinispan" : {

"cache-container" : {

"statistics" : "true",

"metrics" : {

"gauges" : "true",

"histograms" : "true"

}

}

}

}

YAML

infinispan:

cacheContainer:

statistics: "true"

metrics:

gauges: "true"

histograms: "true"

4.2. 注册 JMX MBeans

Data Grid 可以注册可以用来收集统计信息并执行管理操作的 JMX MBeans。您还必须启用统计信息,否则 Data Grid 为 JMX MBeans 中的所有统计属性提供 0 值。

只有在 Data Grid 嵌入于应用程序中而不是远程 Data Grid 服务器时,使用 JMX Mbeans 来收集统计信息。

当您使用 JMX Mbeans 从远程 Data Grid 服务器收集统计信息时,从 JMX Mbeans 接收的数据可能与 REST 等其他 API 接收的数据不同。在这种情况下,从其他 API 接收的数据更为准确。

流程

- 打开 Data Grid 配置以进行编辑。

-

将

jmx元素或对象添加到缓存容器,并将true指定为enabled属性或字段的值。 -

添加

domain属性或字段,并指定公开 JMX MBeans 的域(如果需要)。 - 保存并关闭您的客户端配置。

JMX 配置

XML

<infinispan>

<cache-container statistics="true">

<jmx enabled="true"

domain="example.com"/>

</cache-container>

</infinispan>

JSON

{

"infinispan" : {

"cache-container" : {

"statistics" : "true",

"jmx" : {

"enabled" : "true",

"domain" : "example.com"

}

}

}

}

YAML

infinispan:

cacheContainer:

statistics: "true"

jmx:

enabled: "true"

domain: "example.com"

4.2.1. 启用 JMX 远程端口

提供唯一的远程 JMX 端口,以通过 JMXServiceURL 格式的连接公开数据网格 MBean。

您可以使用以下方法之一启用远程 JMX 端口:

- 启用需要向其中一个 Data Grid 服务器安全域进行身份验证的远程 JMX 端口。

- 使用标准 Java 管理配置选项手动启用远程 JMX 端口。

先决条件

-

对于带有身份验证的远程 JMX,请使用默认安全域定义 JMX 特定的用户角色。用户必须具有具有读/写访问权限的

controlRole,或者具有只读访问权限的monitorRole才能访问任何 JMX 资源。Data Grid 会自动将全局ADMIN和MONITOR权限映射到 JMXcontrolRole和monitorRole角色。

流程

使用以下方法之一启动启用了远程 JMX 端口的 Data Grid 服务器:

通过端口

9999启用远程 JMX。bin/server.sh --jmx 9999

警告在生产环境中不适用于禁用 SSL 的远程 JMX。

在启动时将以下系统属性传递给 Data Grid 服务器。

bin/server.sh -Dcom.sun.management.jmxremote.port=9999 -Dcom.sun.management.jmxremote.authenticate=false -Dcom.sun.management.jmxremote.ssl=false

警告启用没有身份验证或 SSL 的远程 JMX 不安全,在任何环境中都不推荐使用。禁用身份验证和 SSL 允许未授权用户连接到服务器并访问托管的数据。

其他资源

4.2.2. Data Grid MBeans

Data Grid 公开了代表可管理资源的 JMX MBeans。

org.infinispan:type=Cache- 可用于缓存实例的属性和操作。

org.infinispan:type=CacheManager- 可用于缓存管理器的属性和操作,包括数据网格缓存和集群健康统计信息。

有关可用 JMX MBeans 的完整列表以及描述和可用的操作和属性,请参阅 Data Grid JMX 组件 文档。

其他资源

4.2.3. 在自定义 MBean 服务器中注册 MBeans

Data Grid 包含一个 MBeanServerLookup 接口,可用于在自定义 MBeanServer 实例中注册 MBeans。

先决条件

-

创建

MBeanServerLookup的实现,以便getMBeanServer ()方法返回自定义 MBeanServer 实例。 - 配置数据网格以注册 JMX MBeans。

流程

- 打开 Data Grid 配置以进行编辑。

-

将

mbean-server-lookup属性或字段添加到 Cache Manager 的 JMX 配置。 -

指定

MBeanServerLookup实施的完全限定名称(FQN)。 - 保存并关闭您的客户端配置。

JMX MBean 服务器查找配置

XML

<infinispan>

<cache-container statistics="true">

<jmx enabled="true"

domain="example.com"

mbean-server-lookup="com.example.MyMBeanServerLookup"/>

</cache-container>

</infinispan>

JSON

{

"infinispan" : {

"cache-container" : {

"statistics" : "true",

"jmx" : {

"enabled" : "true",

"domain" : "example.com",

"mbean-server-lookup" : "com.example.MyMBeanServerLookup"

}

}

}

}

YAML

infinispan:

cacheContainer:

statistics: "true"

jmx:

enabled: "true"

domain: "example.com"

mbeanServerLookup: "com.example.MyMBeanServerLookup"

4.3. 在状态传输操作过程中导出指标

您可以为跨节点分布集群缓存导出时间指标。

当集群缓存拓扑更改时,状态传输操作发生,如加入或离开集群的节点。在状态传输操作期间,Data Grid 会导出每个缓存中的指标,以便您可以确定缓存的状态。状态传输将属性作为属性公开,以便 Data Grid 可以从每个缓存中导出指标。

您不能在无效模式下执行状态传输操作。

Data Grid 生成与 REST API 和 JMX API 兼容的时间指标。

先决条件

- 配置数据网格指标。

- 为您的缓存类型启用指标,如嵌入式缓存或远程缓存。

- 通过更改集群缓存拓扑来启动状态传输操作。

流程

选择以下任一方法:

- 配置 Data Grid 以使用 REST API 来收集指标。

- 配置 Data Grid 以使用 JMX API 来收集指标。

4.4. 监控跨站点复制的状态

监控备份位置的站点状态,以检测站点之间的通信中断。当远程站点状态变为 离线时,Data Grid 会停止将数据复制到备份位置。您的数据不同步,您必须在使集群重新上线前修复不一致的问题。

对于早期问题检测,需要监控跨站点事件。使用以下监控策略之一:

使用 REST API 监控跨站点复制

使用 REST 端点监控所有缓存的跨站点复制状态。您可以实施自定义脚本来轮询 REST 端点,或者使用以下示例。

先决条件

- 启用跨站点复制。

流程

实施脚本以轮询 REST 端点。

以下示例演示了如何使用 Python 脚本每 5 秒轮询站点状态。

#!/usr/bin/python3

import time

import requests

from requests.auth import HTTPDigestAuth

class InfinispanConnection:

def __init__(self, server: str = 'http://localhost:11222', cache_manager: str = 'default',

auth: tuple = ('admin', 'change_me')) -> None:

super().__init__()

self.__url = f'{server}/rest/v2/container/x-site/backups/'

self.__auth = auth

self.__headers = {

'accept': 'application/json'

}

def get_sites_status(self):

try:

rsp = requests.get(self.__url, headers=self.__headers, auth=HTTPDigestAuth(self.__auth[0], self.__auth[1]))

if rsp.status_code != 200:

return None

return rsp.json()

except:

return None

# Specify credentials for Data Grid user with permission to access the REST endpoint

USERNAME = 'admin'

PASSWORD = 'change_me'

# Set an interval between cross-site status checks

POLL_INTERVAL_SEC = 5

# Provide a list of servers

SERVERS = [

InfinispanConnection('http://127.0.0.1:11222', auth=(USERNAME, PASSWORD)),

InfinispanConnection('http://127.0.0.1:12222', auth=(USERNAME, PASSWORD))

]

#Specify the names of remote sites

REMOTE_SITES = [

'nyc'

]

#Provide a list of caches to monitor

CACHES = [

'work',

'sessions'

]

def on_event(site: str, cache: str, old_status: str, new_status: str):

# TODO implement your handling code here

print(f'site={site} cache={cache} Status changed {old_status} -> {new_status}')

def __handle_mixed_state(state: dict, site: str, site_status: dict):

if site not in state:

state[site] = {c: 'online' if c in site_status['online'] else 'offline' for c in CACHES}

return

for cache in CACHES:

__update_cache_state(state, site, cache, 'online' if cache in site_status['online'] else 'offline')

def __handle_online_or_offline_state(state: dict, site: str, new_status: str):

if site not in state:

state[site] = {c: new_status for c in CACHES}

return

for cache in CACHES:

__update_cache_state(state, site, cache, new_status)

def __update_cache_state(state: dict, site: str, cache: str, new_status: str):

old_status = state[site].get(cache)

if old_status != new_status:

on_event(site, cache, old_status, new_status)

state[site][cache] = new_status

def update_state(state: dict):

rsp = None

for conn in SERVERS:

rsp = conn.get_sites_status()

if rsp:

break

if rsp is None:

print('Unable to fetch site status from any server')

return

for site in REMOTE_SITES:

site_status = rsp.get(site, {})

new_status = site_status.get('status')

if new_status == 'mixed':

__handle_mixed_state(state, site, site_status)

else:

__handle_online_or_offline_state(state, site, new_status)

if __name__ == '__main__':

_state = {}

while True:

update_state(_state)

time.sleep(POLL_INTERVAL_SEC)

当站点状态从 Online 变为 offline 或 vice-versa 时,调用 on_event 的功能。

如果要使用这个脚本,您必须指定以下变量:

-

USERNAME和PASSWORD:Data Grid 用户的用户名和密码,有权访问 REST 端点。 -

POLL_INTERVAL_SEC:轮询之间的秒数。 -

SERVERS:此站点的数据网格服务器列表。该脚本只需要一个有效的响应,但提供了列表以允许故障切换。 -

REMOTE_SITES: 要监控这些服务器上的远程站点列表。 -

CACHES:要监控的缓存名称列表。

其他资源

使用 Prometheus 指标监控跨站点复制

Prometheus 和其他监控系统可让您配置警报来检测站点状态何时更改为 离线。

监控跨站点延迟指标可帮助您发现潜在的问题。

先决条件

- 启用跨站点复制。

流程

- 配置数据网格指标。

使用 Prometheus 指标格式配置警报规则。

-

对于站点状态,

在线使用1,0代表离线。 对于

exprfiled,请使用以下格式:vendor_cache_manager_default_cache_<cache name>_x_site_admin_<site name>_status。在以下示例中,当 NYC 站点为名为

work或 session 的缓存离线时,Prometheus会发出警告。groups: - name: Cross Site Rules rules: - alert: Cache Work and Site NYC expr: vendor_cache_manager_default_cache_work_x_site_admin_nyc_status == 0 - alert: Cache Sessions and Site NYC expr: vendor_cache_manager_default_cache_sessions_x_site_admin_nyc_status == 0下图显示了 NYC 站点

离线进行缓存工作的警报。图 4.1. Prometheus Alert

-

对于站点状态,

第 5 章 配置 JVM 内存用量

控制 Data Grid 如何通过以下方式将数据存储在 JVM 内存中:

- 使用驱除来管理 JVM 内存用量,以自动从缓存中删除数据。

- 将 lifespan 和最大空闲时间添加到过期条目,并防止过时的数据。

- 配置 Data Grid 以将数据保存在非堆原生内存中.

5.1. 默认内存配置

默认情况下,Data Grid 将缓存条目作为对象存储在 JVM 堆中。随着应用添加条目的时间,缓存的大小可能会超过 JVM 可用的内存量。同样,如果 Data Grid 不是主要数据存储,则条目已过时,这意味着您的缓存包含过时的数据。

XML

<distributed-cache> <memory storage="HEAP"/> </distributed-cache>

JSON

{

"distributed-cache": {

"memory" : {

"storage": "HEAP"

}

}

}

YAML

distributedCache:

memory:

storage: "HEAP"

5.2. 驱除和过期

驱除和过期是通过删除旧未使用的条目来清理数据容器的两个策略。虽然驱除和过期时间类似,但它们有一些重要的区别。

- 当容器变得大于配置的阈值时,Data Grid 驱除可让 Data Grid 控制数据容器的大小。

-

rhacm 到期时间限制可以存在的时间条目量。Data Grid 使用调度程序来定期删除过期的条目。过期的但尚未删除的条目会在访问时立即删除;在本例中,已过期条目的

get ()调用返回 "null" 值。 - HEKETI 驱除是 Data Grid 节点的本地。

- 在 Data Grid 集群中进行 5-6 过期。

- swig 您可以将驱除和过期一起使用,也可以相互独立使用。

-

您可以在

infinispan.xml中以声明性方式配置驱除和过期,以便为条目应用缓存范围内的默认值。 - swig 您可以为特定条目显式定义过期设置,但无法基于每个条目定义驱除。

- xmlrpc,您可以手动驱除条目并手动触发过期。

5.3. 使用 Data Grid 缓存驱除

驱除可让您以两种方式之一从内存中删除条目来控制数据容器的大小:

-

条目总数(

max-count)。 -

最大内存量(

max-size)。

驱除一次从数据容器丢弃一个条目,并且对发生的节点而言是本地的。

驱除从内存中删除条目,但不会从持久缓存存储中删除条目。要确保条目在 Data Grid 驱除它们后仍然可用,并防止数据不一致,您应该配置持久性存储。

当您配置 内存 时,Data Grid 大致大致是数据容器的当前内存用量。添加或修改条目时,Data Grid 将数据容器的当前内存用量与最大大小进行比较。如果大小超过最大值,Data Grid 会执行驱除。

驱除会在线程中立即发生,添加超过最大大小的条目。

5.3.1. 驱除策略

当您配置 Data Grid 驱除时,您可以指定:

- 数据容器的最大大小。

- 在缓存达到阈值时删除条目的策略。

您可以手动执行驱除,或者将 Data Grid 配置为执行以下操作之一:

- 删除旧条目以为新条目腾出空间。

抛出

ContainerFullException,并阻止创建新条目。例外驱除策略只适用于使用 2 阶段提交的事务缓存,而不适用于 1 阶段提交或同步优化。

有关驱除策略的详情,请参阅架构引用。

Data Grid 包括 Caffeine 缓存库,它实现了 Least Frequently Used (LFU)缓存替换算法,称为 TinyLFU。对于非堆存储,Data Grid 使用 Least Recently Used (LRU)算法的自定义实现。

其他资源

5.3.2. 配置最大计数驱除

将 Data Grid 缓存的大小限制为条目总数。

流程

- 打开 Data Grid 配置以进行编辑。

-

指定缓存在 Data Grid 执行驱除前可以包含的条目总数,使用

max-count属性或maxCount ()方法。 将以下之一设置为驱除策略,以控制 Data Grid 如何使用

when-full属性或Full ()方法删除条目。-

REMOVEData Grid 执行驱除。这是默认策略。 -

MANUAL为嵌入式缓存手动执行驱除。 -

EXCEPTIONData Grid 会抛出异常而不是驱除条目。

-

- 保存并关闭您的 Data Grid 配置。

最大计数驱除

在以下示例中,当缓存包含总计 500 个条目和新条目时,Data Grid 会删除条目:

XML

<distributed-cache> <memory max-count="500" when-full="REMOVE"/> </distributed-cache>

JSON

{

"distributed-cache" : {

"memory" : {

"max-count" : "500",

"when-full" : "REMOVE"

}

}

}

YAML

distributedCache:

memory:

maxCount: "500"

whenFull: "REMOVE"

ConfigurationBuilder

ConfigurationBuilder builder = new ConfigurationBuilder(); builder.memory().maxCount(500).whenFull(EvictionStrategy.REMOVE);

5.3.3. 配置最大大小驱除

将 Data Grid 缓存的大小限制为最大内存量。

流程

- 打开 Data Grid 配置以进行编辑。

指定

application/x-protostream作为缓存编码的介质类型。您必须指定二进制介质类型才能使用最大大小驱除。

-

配置最大内存量(以字节为单位),缓存可在 Data Grid 使用

max-size属性或maxSize ()方法执行驱除前使用。 (可选)指定测量单位。

默认值为 B (字节)。请参阅 支持的单元的配置模式。

将以下之一设置为驱除策略,以控制 Data Grid 如何使用

when-full属性或whenFull ()方法删除条目。-

REMOVEData Grid 执行驱除。这是默认策略。 -

MANUAL为嵌入式缓存手动执行驱除。 -

EXCEPTIONData Grid 会抛出异常而不是驱除条目。

-

- 保存并关闭您的 Data Grid 配置。

最大大小驱除

在以下示例中,当缓存的大小达到 1.5 GB (千兆字节)和新条目时,Data Grid 会删除条目:

XML

<distributed-cache> <encoding media-type="application/x-protostream"/> <memory max-size="1.5GB" when-full="REMOVE"/> </distributed-cache>

JSON

{

"distributed-cache" : {

"encoding" : {

"media-type" : "application/x-protostream"

},

"memory" : {

"max-size" : "1.5GB",

"when-full" : "REMOVE"

}

}

}

YAML

distributedCache:

encoding:

mediaType: "application/x-protostream"

memory:

maxSize: "1.5GB"

whenFull: "REMOVE"

ConfigurationBuilder

ConfigurationBuilder builder = new ConfigurationBuilder();

builder.encoding().mediaType("application/x-protostream")

.memory()

.maxSize("1.5GB")

.whenFull(EvictionStrategy.REMOVE);

5.3.4. 手动驱除

如果您选择手动驱除策略,Data Grid 不会执行驱除。您必须使用 evict () 方法手动完成此操作。

您应该只在嵌入式缓存中使用手动驱除。对于远程缓存,您应该始终使用 REMOVE 或 EXCEPTION 驱除策略配置 Data Grid。

此配置可防止当您启用 passivation 时警告信息,但没有配置驱除。

XML

<distributed-cache> <memory max-count="500" when-full="MANUAL"/> </distributed-cache>

JSON

{

"distributed-cache" : {

"memory" : {

"max-count" : "500",

"when-full" : "MANUAL"

}

}

}

YAML

distributedCache:

memory:

maxCount: "500"

whenFull: "MANUAL"

ConfigurationBuilder

ConfigurationBuilder builder = new ConfigurationBuilder();

builder.encoding().mediaType("application/x-protostream")

.memory()

.maxSize("1.5GB")

.whenFull(EvictionStrategy.REMOVE);

5.3.5. 使用驱除进行传递

当 Data Grid 驱除条目时,传递会保留数据到缓存存储。如果启用 passivation,则应始终启用驱除,如下例所示:

XML

<distributed-cache>

<persistence passivation="true">

<!-- Persistent storage configuration. -->

</persistence>

<memory max-count="100"/>

</distributed-cache>

JSON

{

"distributed-cache": {

"memory" : {

"max-count" : "100"

},

"persistence" : {

"passivation" : true

}

}

}

YAML

distributedCache:

memory:

maxCount: "100"

persistence:

passivation: "true"

ConfigurationBuilder

ConfigurationBuilder builder = new ConfigurationBuilder(); builder.memory().maxCount(100); builder.persistence().passivation(true); //Persistent storage configuration

5.4. 带有生命周期和最大闲置的过期时间

expiration 配置 Data Grid,以便在达到以下时间限制时从缓存中删除条目:

- Lifespan

- 设置条目可以存在的最长时间。

- 最大闲置

- 指定条目可以保持闲置的时长。如果没有对条目发生操作,则它们就会被闲置。

最大闲置过期目前不支持使用持久性存储的缓存。

如果您将过期和驱除用于 EXCEPTION 驱除策略、已过期但尚未从缓存中删除的条目,则计数为数据容器的大小。

5.4.1. 过期如何工作

当您配置过期时,Data Grid 会使用决定何时过期的元数据存储密钥。

-

lifespan 使用

创建时间戳和 lifespan配置属性的值。 -

最大闲置使用

最后一个使用的时间戳,以及max-idle配置属性的值。

Data Grid 检查是否设置了 lifespan 或最大空闲元数据,然后将值与当前时间进行比较。

如果 (creation + lifespan < currentTime) 或 (lastUsed + maxIdle < currentTime),Data Grid 检测到该条目已过期。

每当访问条目或由过期后找到条目时,就会过期。

例如,k1 达到最大空闲时间,客户端发出 Cache.get (k1) 请求。在这种情况下,Data Grid 检测到条目已过期,并将其从数据容器中删除。Cache.get (k1) 请求返回 null。

网格也会从缓存存储中过期条目,但只适用于生命周期到期。最大闲置过期不适用于缓存存储。对于缓存加载程序,Data Grid 无法使条目过期,因为加载程序只能从外部存储读取。

Data Grid 将 长 原语数据类型添加到缓存条目的过期元数据。这可增加密钥的大小,其大小为 32 字节。

5.4.2. 过期原因

Data Grid 使用一个定期运行的收款线程来检测和删除过期的条目。过期后期将确保不再访问的过期条目已被删除。

Data Grid ExpirationManager 接口处理 expiration reaper,并公开 processExpiration () 方法。

在某些情况下,您可以禁用过期时间恢复程序并通过调用 processExpiration () 来手动过期条目;例如,如果您使用本地缓存模式并定期运行维护线程的自定义应用程序。

如果使用集群缓存模式,则永远不会禁用过期过程。

在使用缓存存储时,网格始终使用过期程序。在这种情况下,您无法禁用它。

5.4.3. 最大闲置和集群缓存

因为最大闲置过期取决于缓存条目的最后访问时间,所以它有一些集群缓存模式的限制。

通过生命周期期限,缓存条目的创建时间提供跨集群缓存的一致性值。例如,所有节点上的 k1 创建时间都相同。

对于使用集群缓存的最大闲置过期,条目的最后访问时间并不始终在所有节点上相同。为确保在集群间都有相同的相对访问时间,当访问密钥时,Data Grid 会将 touch 命令发送到所有所有者。

Data Grid 发送的 touch 命令具有以下注意事项:

-

cache.get ()请求不会返回,直到所有 touch 命令都完成。此同步行为会增加客户端请求的延迟。 - touch 命令还会更新所有所有者上的缓存条目的"重新访问"元数据,Data Grid 用于驱除。

附加信息

- 最大闲置过期不适用于 invalidation 模式。

- 集群缓存中的迭代可以返回超过最大空闲时间限制的过期条目。此行为可确保性能,因为在迭代过程中不会执行远程调用。另请注意,迭代不会刷新任何过期的条目。

5.4.4. 为缓存配置 lifespan 和最大闲置时间

为缓存中的所有条目设置 lifespan 和最大闲置时间。

流程

- 打开 Data Grid 配置以进行编辑。

-

指定条目可以使用

lifespan属性或lifespan ()方法保留在缓存中的时间(以毫秒为单位)。 -

使用

max-idle属性或maxIdle ()方法,指定条目在最后一次访问后可以保持闲置的时间(以毫秒为单位)。 - 保存并关闭您的 Data Grid 配置。

Data Grid 缓存过期

在以下示例中,Data Grid 会在最后一次访问时间后 5 秒或 1 秒后过期所有缓存条目,以先发生:

XML

<replicated-cache> <expiration lifespan="5000" max-idle="1000" /> </replicated-cache>

JSON

{

"replicated-cache" : {

"expiration" : {

"lifespan" : "5000",

"max-idle" : "1000"

}

}

}

YAML

replicatedCache:

expiration:

lifespan: "5000"

maxIdle: "1000"

ConfigurationBuilder

ConfigurationBuilder builder = new ConfigurationBuilder();

builder.expiration().lifespan(5000, TimeUnit.MILLISECONDS)

.maxIdle(1000, TimeUnit.MILLISECONDS);

5.4.5. 配置每个条目的 lifespan 和最大闲置时间

为单个条目指定 lifespan 和最大闲置时间。当您向条目添加 lifespan 和最大闲置时间时,这些值优先于缓存过期配置。

当您为缓存条目明确定义 lifespan 和最大空闲时间值时,Data Grid 会在集群中复制这些值,以及缓存条目。同样,Data Grid 也会将过期值和条目写入持久性存储。

流程

对于远程缓存,您可以将 lifespan 和最大闲置时间添加到通过 Data Grid 控制台交互的条目。

使用 Data Grid 命令行界面(CLI),通过

put命令使用--max-idle参数。=和--ttl=对于远程和嵌入式缓存,您可以使用

cache.put ()调用添加 lifespan 和 maximum idle times。//Lifespan of 5 seconds. //Maximum idle time of 1 second. cache.put("hello", "world", 5, TimeUnit.SECONDS, 1, TimeUnit.SECONDS); //Lifespan is disabled with a value of -1. //Maximum idle time of 1 second. cache.put("hello", "world", -1, TimeUnit.SECONDS, 1, TimeUnit.SECONDS);

5.5. JVM heap 和 off-heap 内存

默认情况下,Data Grid 将缓存条目存储在 JVM 堆内存中。您可以将 Data Grid 配置为使用非堆存储,这意味着您的数据会占用受管 JVM 内存空间之外的原生内存。

下图显示了运行 Data Grid 的 JVM 进程的内存空间:

图 5.1. JVM 内存空间

JVM 堆内存

堆分为年轻而旧代,可帮助在内存中保持引用的 Java 对象和其他应用数据。GC 进程从无法访问的对象回收空间,在生成内存池中更频繁地运行。

当 Data Grid 将缓存条目存储在 JVM 堆内存中时,GC 运行可能需要更长的时间才能开始向缓存中添加数据。因为 GC 是一个密集型过程,所以更频繁地运行可能会降低应用程序性能。

off-heap 内存

off-heap 内存是 JVM 内存管理之外的原生可用内存。JVM 内存空间 图显示包含类元数据且从原生内存分配的 Metaspace 内存池。该图还代表了包含 Data Grid 缓存条目的原生内存部分。

off-heap 内存:

- 每个条目使用较少的内存。

- 通过避免 Garbage Collector (GC)运行来提高整体 JVM 性能。

但是,一个缺点是 JVM 堆转储不显示存储在 off-heap 内存中的条目。

5.5.1. 非堆数据存储

当您向现成缓存中添加条目时,Data Grid 会动态地为您的数据分配原生内存。

Data Grid 将每个 键的序列化字节[] 哈希到与标准 Java HashMap 类似的存储桶中。bucket 包括 Data Grid 用来查找存储在 off-heap 内存中的条目的地址指针。

虽然 Data Grid 将缓存条目存储在原生内存中,但运行时操作需要这些对象的 JVM 堆表示。例如,cache.get () 操作会在返回前将对象读取到堆内存中。同样,状态传输操作在堆内存中保存对象子集。

对象相等

Data Grid 使用每个对象的序列化字节[]表示,而不是对象实例,以非堆存储的形式确定 Java 对象的相等性。

数据一致性

Data Grid 使用数组锁定来保护非堆地址空间。锁定的数量是内核数的两倍,然后舍入到最接近的 2 的指数。这样可确保存在 ReadWriteLock 实例甚至分配,以防止写入操作阻止读操作。

5.5.2. 配置离线内存

配置 Data Grid,以将缓存条目存储在 JVM 堆空间之外的原生内存中。

流程

- 打开 Data Grid 配置以进行编辑。

-

将

OFF_HEAP设置为storage属性或storage ()方法的值。 - 通过配置驱除来为缓存大小设置边界。

- 保存并关闭您的 Data Grid 配置。

off-heap 存储

网格将缓存条目存储为原生内存中的字节。当数据容器中有 100 个条目,并且 Data Grid 获取创建新条目的请求时发生驱除:

XML

<replicated-cache> <memory storage="OFF_HEAP" max-count="500"/> </replicated-cache>

JSON

{

"replicated-cache" : {

"memory" : {

"storage" : "OFF_HEAP",

"max-count" : "500"

}

}

}

YAML

replicatedCache:

memory:

storage: "OFF_HEAP"

maxCount: "500"

ConfigurationBuilder

ConfigurationBuilder builder = new ConfigurationBuilder(); builder.memory().storage(StorageType.OFF_HEAP).maxCount(500);

第 6 章 配置持久性存储

网格使用缓存存储和加载程序与持久性存储交互。

- 持久性

- 通过添加缓存存储,您可以将数据持久化到非易失性存储中,以便在重启后保留。

- 直写缓存

- 将 Data Grid 配置为持久性存储前面的缓存层简化了应用程序的数据访问,因为 Data Grid 处理与外部存储的所有交互。

- 数据溢出

- 使用驱除和传递技术可确保 Data Grid 只保留频繁使用的数据在内存中,并将旧的条目写入持久性存储。

6.1. passivation

传递配置 Data Grid,以便在从内存中驱除这些条目时将条目写入缓存存储。这样,传递可以防止不必要的,可能昂贵的写入持久性存储。

当尝试访问传递的条目时,激活是从缓存存储恢复到内存的过程。因此,当启用传递时,您必须配置实现 CacheWriter 和 CacheLoader 接口的缓存存储,以便它们可以从持久性存储写入和加载条目。

当 Data Grid 从缓存中驱除条目时,它会通知缓存监听程序,该条目被传递,然后将条目存储在缓存存储中。当 Data Grid 获得对被驱除条目的访问请求时,它会很快地将缓存存储中的条目加载到内存中,然后通知缓存监听程序,使条目在存储中保持仍然在存储中。

- passivation 使用 Data Grid 配置中的第一个缓存加载程序,并忽略所有其他缓存。

不支持 passivation:

- 事务性存储.传递写入并从实际 Data Grid 提交边界范围以外的存储中删除条目。

- 共享存储。共享缓存存储需要条目始终存在于其他所有者的存储中。因此,不支持 passivation,因为无法删除条目。

如果您启用对事务存储或共享存储的 passivation,Data Grid 会抛出异常。

6.1.1. 传递是如何工作的

禁用传递

写入内存中的数据会导致写入持久性存储。

如果 Data Grid 从内存中驱除数据,则持久性存储中的数据包括从内存中驱除的条目。这样,持久性存储是内存缓存的超集。当您需要最高一致性时,建议您这样做,因为存储可以在崩溃后再次读取。

如果没有配置驱除,则持久性存储中的数据会在内存中提供数据副本。

启用 passivation

网格仅在从内存驱除数据时将数据添加到持久性存储中,条目会被删除或关闭该节点。

当 Data Grid 激活条目时,它会在内存中恢复数据,但仍然保留存储中的数据。这样,写入可以在没有存储的情况下尽快进行,并且仍然保持一致性。当只创建或更新一个条目时,将更新内存中的,因此存储将已过时。

当存储也配置为共享时,不支持 passivation。这是因为当写入被驱除与读相比,条目可能会在节点间不同步。

为了提高数据一致性,任何不是共享的存储都应启用 purgeOnStartup。对于启用或禁用 passivation,因此这是正确的,因为存储可能会保存一个过时的条目,同时停止它,并在以后被忽略。

下表显示了在一系列操作后内存和持久性存储中的数据:

| 操作 | 禁用传递 | 启用 passivation |

|---|---|---|

| 插入 k1。 |

memory: k1 |

内存: k1 |

| 插入 k2. |

memory: k1, k2 |

memory: k1, k2 |

| 驱除线程运行和驱除 k1。 |

memory: k2 |

memory: k2 |

| 读取 k1。 |

memory: k1, k2 |

memory: k1, k2 |

| 驱除线程运行和驱除 k2。 |

memory: k1 |

memory: k1 |

| 删除 k2。 |

memory: k1 |

memory: k1 |

6.2. 直写缓存存储

直写模式是一种缓存写入模式,对缓存存储进行写入和写入是同步的。当客户端应用程序通过调用 Cache.put () 更新缓存条目时,在大多数情形中,Data Grid 不会返回调用,直到更新缓存存储为止。这个缓存写入模式会导致客户端线程边界内对缓存存储进行更新。

write-through 模式的主要优点是,缓存和缓存存储会同时更新,这样可确保缓存存储始终与缓存一致。

但是,直写模式可能会降低性能,因为访问和更新缓存存储直接为缓存操作添加延迟。

直写配置

网格使用直写模式,除非您在缓存中明确添加 write-behind 配置。配置直写模式没有单独的元素或方法。

例如,以下配置在隐式使用 write-through 模式的缓存中添加了一个基于文件的存储:

<distributed-cache>

<persistence passivation="false">

<file-store>

<index path="path/to/index" />

<data path="path/to/data" />

</file-store>

</persistence>

</distributed-cache>6.3. write-behind 缓存存储

write-behind 是一个缓存写入模式,对内存的写入是同步的,对缓存存储的写入是异步的。

当客户端发送写入请求时,Data Grid 会将这些操作添加到修改队列中。Data Grid 在它们加入队列时处理操作,因此调用线程不会被阻止,操作会立即完成。

如果修改队列中的写入操作数量超过队列的大小,Data Grid 会将这些额外的操作添加到队列中。但是,在 Data Grid 进程已在队列中已有的操作之前,这些操作才会完成。

例如,调用 Cache.putAsync 可立即返回,如果修改队列未满,Stage 也会立即完成。如果修改队列已满,或者 Data Grid 当前正在处理一系列写入操作,则 Cache.putAsync 立即返回,Stage 则完成。

write-behind 模式比直写模式提供了性能优势,因为缓存操作不需要等待对底层缓存存储的更新完成。但是,缓存存储中的数据会与缓存中的数据不一致,直到处理修改队列为止。因此,write-behind 模式适用于具有低延迟的缓存存储,如未共享和基于文件的缓存存储,其中写入缓存的时间和对缓存存储的写入是尽可能小的。

write-behind 配置

XML

<distributed-cache>

<persistence>

<table-jdbc-store xmlns="urn:infinispan:config:store:sql:15.0"

dialect="H2"

shared="true"

table-name="books">

<connection-pool connection-url="jdbc:h2:mem:infinispan"

username="sa"

password="changeme"

driver="org.h2.Driver"/>

<write-behind modification-queue-size="2048"

fail-silently="true"/>

</table-jdbc-store>

</persistence>

</distributed-cache>

JSON

{

"distributed-cache": {

"persistence" : {

"table-jdbc-store": {

"dialect": "H2",

"shared": "true",

"table-name": "books",

"connection-pool": {

"connection-url": "jdbc:h2:mem:infinispan",

"driver": "org.h2.Driver",

"username": "sa",

"password": "changeme"

},

"write-behind" : {

"modification-queue-size" : "2048",

"fail-silently" : true

}

}

}

}

}

YAML

distributedCache:

persistence:

tableJdbcStore:

dialect: "H2"

shared: "true"

tableName: "books"

connectionPool:

connectionUrl: "jdbc:h2:mem:infinispan"

driver: "org.h2.Driver"

username: "sa"

password: "changeme"

writeBehind:

modificationQueueSize: "2048"

failSilently: "true"

ConfigurationBuilder

ConfigurationBuilder builder = new ConfigurationBuilder();

builder.persistence()

.async()

.modificationQueueSize(2048)

.failSilently(true);

静默失败

write-behind 配置包含一个 fail-silently 参数,用于控制缓存存储不可用或者修改队列已满时发生的情况。

-

如果

fail-silently="true",Data Grid 会记录 WARN 消息并拒绝写操作。 如果

fail-silently="false",如果 Data Grid 在写操作过程中检测到缓存存储不可用,则 Data Grid 会抛出异常。同样,如果修改队列已满,Data Grid 会抛出异常。在某些情况下,如果修改队列中存在 Data Grid 重启和写操作,则可能会出现数据丢失。例如,缓存存储离线,但在检测缓存存储不可用时,写入操作会添加到修改队列中,因为它没有满。如果在缓存存储恢复前 Data Grid 重启或其他不可用,则修改队列中的写入操作将会丢失,因为它们不会被保留。

6.4. 分段缓存存储

缓存存储可以将数据组织到哪些键映射的散列空间片段中。

片段存储提高了批量操作的读取性能;例如,通过数据流(Cache.size、Cache.entrySet.stream)、预加载缓存以及执行状态传输操作。

但是,片段存储也可以导致写操作的性能丢失。此性能丢失特别适用于批量写入操作,它们可能会发生事务或写入性存储。因此,您应该在启用网段存储前评估写操作的开销。如果写入操作有显著的性能损失,则批量读取操作的性能可能无法接受。

为缓存存储配置的片段数量必须与您在 Data Grid 配置中定义的片段数与 cluster. hash.numSegments 参数匹配。

如果在添加分段缓存存储后更改了配置中的 numSegments 参数,Data Grid 无法从该缓存存储中读取数据。

6.6. 带有持久缓存存储的事务

Data Grid 仅支持使用基于 JDBC 的缓存存储的事务操作。要将缓存配置为事务,请设置 transactional=true,使持久性存储中的数据与内存中的数据同步。

对于所有其他缓存存储,Data Grid 在事务操作中不会包括缓存加载程序。如果事务成功在内存中修改数据,这可能会导致数据不一致,但不会完全应用缓存存储中数据的更改。在这些情况下,无法使用缓存存储进行手动恢复。

6.7. 全局持久性位置

Data Grid 保留全局状态,以便它在重启后可以恢复集群拓扑和缓存的数据。

Data Grid 使用文件锁定来防止并发访问全局持久位置。锁定在启动时获取,并在节点关闭时释放。存在悬停的锁定文件表示节点没有完全关闭,无论是因为崩溃或外部终止而被完全关闭。在默认配置中,Data Grid 将拒绝启动以避免出现以下消息的数据损坏:

ISPN000693: Dangling lock file '%s' in persistent global state, probably left behind by an unclean shutdown

通过将全局状态 unclean-shutdown-action 设置配置为以下之一来更改行为:

-

FAIL: 如果 dangling 锁定文件处于持久的全局状态,则缓存管理器的启动。这是默认的行为。 -

PURGE:清除持久的全局状态,如果 dangling 锁定文件处于持久全局状态。 -

IGNORE:忽略持久性全局状态下形锁定文件。

远程缓存

Data Grid 服务器将集群状态保存到 $RHDG_HOME/server/data 目录中。

您不应该删除或修改 server/data 目录或其内容。在重启服务器实例时,Data Grid 从此目录恢复集群状态。

更改默认配置或直接修改 server/data 目录可能会导致意外行为,并导致数据丢失。

嵌入式缓存

Data Grid 默认为 user.dir 系统属性作为全局持久位置。在大多数情况下,这是应用程序启动的目录。

对于复制或分布式集群嵌入式缓存,您应该始终启用并配置全局持久位置来恢复集群拓扑。

您永远不会为基于文件的缓存存储配置绝对路径,该存储位于全局持久位置之外。如果您这样做,Data Grid 会将以下例外写入日志:

ISPN000558: "The store location 'foo' is not a child of the global persistent location 'bar'"

6.7.1. 配置全局持久位置

启用并配置 Data Grid 存储集群嵌入式缓存的全局状态的位置。

Data Grid 服务器实现全局持久性并配置默认位置。您不应该禁用全局持久性或更改远程缓存的默认配置。

先决条件

- 将 Data Grid 添加到您的项目。

流程

使用以下方法之一启用全局状态:

-

将

global-state元素添加到您的 Data Grid 配置中。 -

在

GlobalConfigurationBuilderAPI 中调用globalState ().enable ()方法。

-

将

定义全局持久位置是否对每个节点是唯一的,还是在集群间共享。

位置类型 配置 每个节点的唯一

persistent-location元素或persistentLocation ()方法在集群中共享

shared-persistent-location元素或sharedPersistentLocation (String)方法设置 Data Grid 存储集群状态的路径。

例如,基于文件的缓存存储了路径是主机文件系统上的目录。

值可以是:

- 绝对并包含完整位置,包括 root 用户。

- 相对于根位置。

如果为路径指定相对值,还必须指定一个解析为根位置的系统属性。

例如,在 Linux 主机系统中,您将

global/state设置为路径。您还可以设置解析到/opt/data根位置的my.data属性。在这种情况下,Data Grid 使用/opt/data/global/state作为全局持久位置。

全局持久性位置配置

XML

<infinispan>

<cache-container>

<global-state>

<persistent-location path="global/state" relative-to="my.data"/>

</global-state>

</cache-container>

</infinispan>

JSON

{

"infinispan" : {

"cache-container" : {

"global-state": {

"persistent-location" : {

"path" : "global/state",

"relative-to" : "my.data"

}

}

}

}

}

YAML

cacheContainer:

globalState:

persistentLocation:

path: "global/state"

relativeTo : "my.data"

GlobalConfigurationBuilder

new GlobalConfigurationBuilder().globalState()

.enable()

.persistentLocation("global/state", "my.data");

6.8. 基于文件的缓存存储

基于文件的缓存存储可在运行 Data Grid 的本地主机文件系统上提供持久存储。对于集群缓存,基于文件的缓存存储对于每个 Data Grid 节点都是唯一的。

切勿将基于文件系统的缓存存储在共享文件系统上,如 NFS 或 Samba 共享,因为它们不提供文件锁定功能和数据损坏。

另外,如果您试图将事务缓存与共享文件系统搭配使用,在提交阶段写入文件时可能会出现不可恢复的故障。

soft-Index File Stores

SoftIndexFileStore 是基于文件的缓存存储的默认实现,并将数据存储在一组仅附加文件中。

当只附加文件时:

- 达到其最大大小时,Data Grid 会创建一个新文件并开始写入该文件。

- 达到低于 50% 的压缩阈值,Data Grid 将条目覆盖新文件,然后删除旧文件。

在集群缓存中使用 SoftIndexFileStore 应该在启动时启用清除,以确保不会重新恢复过时的条目。

b+ 树

为提高性能,SoftIndexFileStore 中仅附加文件使用可保存在磁盘和内存中的 B+ Tree 进行索引。内存中索引使用 Java 软引用来确保如果由 Garbage Collection (GC)删除,则可以重新构建它,然后再次请求。

由于 SoftIndexFileStore 使用 Java 软引用来在内存中保留索引,因此这有助于防止内存不足异常。GC 在消耗太多内存前删除索引,同时仍然回退到磁盘。

SoftIndexFileStore 为每个配置的缓存段创建一个 B+ 树。这提供了一个额外的 "index",因为它只有多个元素,并为索引更新提供额外的并行性。目前,我们允许一个基于缓存片段数量的 6 个并行数量。

B+ 树中的每个条目都是节点。默认情况下,每个节点的大小限制为 4096 字节。如果密钥在序列化发生后较长,SoftIndexFileStore 会抛出异常。

文件限制

SoftIndexFileStore 将使用两个以及给定时间配置的 openFilesLimit 数量。为新更新的数据保留两个额外的文件指针,为日志附加器保留另一个用于压缩条目到新文件中。

为索引分配的打开的文件量是配置的 openFilesLimit 的总数之一。这个数字至少为 1 或缓存片段数。为打开数据文件本身分配从配置的限制中重新处理的任何数字。

分段

软索引文件存储始终是网段的。附加日志不是直接分段的,分段直接由索引处理。

过期

SoftIndexFileStore 对过期条目及其要求有全面支持。

单个文件缓存存储

单个文件缓存存储现已弃用,并计划删除。

单个文件缓存存储,SingleFileStore,将数据保留到文件。Data Grid 还维护一个键的内存中索引,而键和值则存储在文件中。

由于 SingleFileStore 保留一个键的内存索引和值位置,因此需要额外的内存,具体取决于密钥大小和键数量。因此,对于密钥较大或者数量较大,我们不推荐使用 SingleFileStore。

在某些情况下,SingleFileStore 也可以变得碎片。如果值大小持续增加,则不会使用单个文件中的可用空间,但该条目会附加到文件末尾。只有在条目可以适合时,才会使用文件中的可用空间。同样,如果您从内存中删除所有条目,则单个文件存储不会减小或进行碎片整理。

分段

默认情况下,单个文件缓存存储被分段为为每个片段有一个单独的实例,这会导致多个目录。每个目录都是代表数据映射段的数字。

6.8.1. 配置基于文件的缓存存储

将基于文件的缓存存储到 Data Grid,以在主机文件系统中保留数据。

先决条件

- 如果您要配置嵌入式缓存,请启用全局状态并配置全局持久位置。

流程

-

在您的缓存配置中添加

persistence元素。 -

(可选)指定

true作为passivation属性的值,以便仅在数据从内存中驱除时写入基于文件的缓存存储。 -

包含

file-store元素,并根据情况配置属性。 指定

false作为shared属性的值。基于文件的缓存存储对于每个 Data Grid 实例应始终是唯一的。如果要在集群中使用相同的持久性,请配置基于 JDBC 字符串的缓存存储等共享存储。

-

配置

索引和数据元素,以指定 Data Grid 创建索引并存储数据的位置。 -

如果要使用

write-behind模式配置缓存存储,请包含 write-behind 元素。

基于文件的缓存存储配置

XML

<distributed-cache>

<persistence passivation="true">

<file-store shared="false">

<data path="data"/>

<index path="index"/>

<write-behind modification-queue-size="2048" />

</file-store>

</persistence>

</distributed-cache>

JSON

{

"distributed-cache": {

"persistence": {

"passivation": true,

"file-store" : {

"shared": false,

"data": {

"path": "data"

},

"index": {

"path": "index"

},

"write-behind": {

"modification-queue-size": "2048"

}

}

}

}

}

YAML

distributedCache:

persistence:

passivation: "true"

fileStore:

shared: "false"

data:

path: "data"

index:

path: "index"

writeBehind:

modificationQueueSize: "2048"

ConfigurationBuilder

ConfigurationBuilder builder = new ConfigurationBuilder();

builder.persistence().passivation(true)

.addSoftIndexFileStore()

.shared(false)

.dataLocation("data")

.indexLocation("index")

.modificationQueueSize(2048);

6.8.2. 配置单个文件缓存存储

如果需要,您可以将 Data Grid 配置为创建单个文件存储。

单个文件存储已弃用。与单个文件存储相比,您应该使用 soft-index 文件存储来提高性能和数据一致性。

先决条件

- 如果您要配置嵌入式缓存,请启用全局状态并配置全局持久位置。

流程

-

在您的缓存配置中添加

persistence元素。 -

(可选)指定

true作为passivation属性的值,以便仅在数据从内存中驱除时写入基于文件的缓存存储。 -

包含

single-file-store元素。 -

指定

false作为shared属性的值。 - 根据需要配置任何其他属性。

-

包含

write-behind元素,将缓存存储配置为后面的写入,而不是作为写入。

单个文件缓存存储配置

XML

<distributed-cache>

<persistence passivation="true">

<single-file-store shared="false"

preload="true"/>

</persistence>

</distributed-cache>

JSON

{

"distributed-cache": {

"persistence" : {

"passivation" : true,

"single-file-store" : {

"shared" : false,

"preload" : true

}

}

}

}

YAML

distributedCache:

persistence:

passivation: "true"

singleFileStore:

shared: "false"

preload: "true"

ConfigurationBuilder

ConfigurationBuilder builder = new ConfigurationBuilder();

builder.persistence().passivation(true)

.addStore(SingleFileStoreConfigurationBuilder.class)

.shared(false)

.preload(true);

6.9. JDBC 连接工厂

Data Grid 提供不同的 ConnectionFactory 实施,供您连接到数据库。您可以将 JDBC 连接与 SQL 缓存存储搭配使用,以及基于 JDBC 字符串的缓存存储。

连接池

连接池适合独立 Data Grid 部署,且基于 Agroal。

XML

<distributed-cache>

<persistence>

<connection-pool connection-url="jdbc:h2:mem:infinispan;DB_CLOSE_DELAY=-1"

username="sa"

password="changeme"

driver="org.h2.Driver"/>

</persistence>

</distributed-cache>

JSON

{

"distributed-cache": {

"persistence": {

"connection-pool": {

"connection-url": "jdbc:h2:mem:infinispan_string_based",

"driver": "org.h2.Driver",

"username": "sa",

"password": "changeme"

}

}

}

}

YAML

distributedCache:

persistence:

connectionPool:

connectionUrl: "jdbc:h2:mem:infinispan_string_based;DB_CLOSE_DELAY=-1"

driver: org.h2.Driver

username: sa

password: changeme

ConfigurationBuilder

ConfigurationBuilder builder = new ConfigurationBuilder();

builder.persistence()

.connectionPool()

.connectionUrl("jdbc:h2:mem:infinispan_string_based;DB_CLOSE_DELAY=-1")

.username("sa")

.driverClass("org.h2.Driver");

受管数据源

数据源连接适合托管环境,如应用服务器。

XML

<distributed-cache>

<persistence>

<data-source jndi-url="java:/StringStoreWithManagedConnectionTest/DS" />

</persistence>

</distributed-cache>

JSON

{

"distributed-cache": {

"persistence": {

"data-source": {

"jndi-url": "java:/StringStoreWithManagedConnectionTest/DS"

}

}

}

}

YAML

distributedCache:

persistence:

dataSource:

jndiUrl: "java:/StringStoreWithManagedConnectionTest/DS"

ConfigurationBuilder

ConfigurationBuilder builder = new ConfigurationBuilder();

builder.persistence()

.dataSource()

.jndiUrl("java:/StringStoreWithManagedConnectionTest/DS");

简单连接

简单的连接工厂在每个调用基础上创建数据库连接,仅用于测试或开发环境。

XML

<distributed-cache>

<persistence>

<simple-connection connection-url="jdbc:h2://localhost"

username="sa"

password="changeme"

driver="org.h2.Driver"/>

</persistence>

</distributed-cache>

JSON

{

"distributed-cache": {