Red Hat Training

A Red Hat training course is available for Red Hat Enterprise Linux

Guia de Segurança

Um Guia para Proteger o Red Hat Enterprise Linux

Edição 1.5

Red Hat Inc.

Resumo

Capítulo 1. Visão Geral da Segurança

Nota

/lib. Se estiver usando os sistemas 64 bits, alguns dos arquivos mencionados podem estar localizados no /lib64.

1.1. Introdução à Segurança

1.1.1. O que é Segurança de Computadores?

1.1.1.1. Como a Segurança de Computadores começou?

1.1.1.2. A Segurança Hoje

- Em qualquer dia, existem aproximadamente 225 importantes incidências de brecha de segurança reportadas ao CERT Coordination Center at Carnegie Mellon University.[6]

- O número de incidentes reportados no CERT pulou de 52,658 em 2001, 82,094 em 2002 e para 137,529 em 2003.[7]

- De acordo com o FBI, crimes relacionados à computadores custou às empresas americanas $67.2 bilhões de dólares em 2006.[8]

- Apenas 23% dos que responderam possuem políticas para o uso das tecnologias de Web 2.0. Estas tecnologias, como Twitter, Facebook e LinkedIn podem oferecer uma maneira conveniente para empresas e individuais se comunicarem e colaborar, entretanto elas abrem novas vulnerabilidades, primariamente o vazamento de dados confidenciais.

- Mesmo durante a recente crise financeira de 2009, a pesquisa constatou que os orçamentos com segurança estavam no mesmo nível ou em crescimento em relação aos anos anteriores (aproximadamente 2 de cada 3 participantes esperam aumentar ou manter o mesmo nível). Isto é uma boa notícia e reflete a importância que organizações estão dando na segurança da informação hoje.

1.1.1.3. Padronização da Segurança

- Confidencialidade — Informações sensíveis devem estar disponíveis somente para um conjunto de indivíduos pré definidos. Transmissão não autorizada e uso da informação devem ser restritos. Por exemplo, a confidencialidade da informação garante que uma informação pessoal ou financeira não seja obtida por um indivíduo não autorizado para propósitos maliciosos tais como roubo de identidade ou fraude de crédito.

- Integridade — As informações não devem ser alteradas de modo a torna-las incompletas ou incorretas. Usuários não autorizados devem ser restritos da possibilidade de modificar ou destruir informações sensíveis.

- Disponibilidade — As informações devem ser acessíveis a usuários autorizados em qualquer momento que seja necessário. Disponibilidade é uma garantia que a informação pode ser obtida com acordos de frequência e pontualidade. Isto é frequentemente medido em termos de porcentagens e definido formalmente em Acordos de Nível de Serviço (SLAs) usados por provedores de serviços de redes e seus clientes corporativos.

1.1.2. SELinux

1.1.3. Controles de Segurança

- Físico

- Técnico

- Administrativo

1.1.3.1. Controles Físicos

- Cameras de vigilância de circuito interno

- Sistemas de alarmes térmicos ou de movimento

- Guardas de Segurança

- IDs com fotos

- Portas de aço bloqueadas com parafusos sem cabeça

- Biometria (inclui impressão digital, voz, rosto, íris, manuscrito e outros métodos automatizados usados para reconhecer indivíduos)

1.1.3.2. Controles Técnicos

- Criptografia

- Cartões Smart

- Autenticação de rede

- Listas de Controle de Acesso (ACLs)

- Software de auditoria de integridade de arquivos

1.1.3.3. Controles Administrativos

- Treinamento e conscientização

- Prevenção de desastres e planos de recuperação

- Estratégias de recrutamento de pessoal e de separação

- Registro de pessoal e de contabilidade

1.1.4. Conclusão

1.2. Avaliação de Vulnerabilidade

- A perícia do pessoal responsável pela configuração, monitoramento e manutenção das tecnologias.

- A habilidade de corrigir e atualizar serviços e kernels rapidamente e eficientemente.

- A habilidade daqueles responsáveis em manter constante vigilância sobre a rede.

1.2.1. Pensando Como o Inimigo

1.2.2. Definindo a Avaliação e Testes

Atenção

- Cria um foco pró ativo na segurança da informação

- Encontra potenciais explorações antes que os invasores as encontrem

- Resulta em sistemas sendo atualizados e corrigidos

- Promove o crescimento e ajuda no desenvolvimento das habilidades dos funcionários

- Reduz perdas financeiras e publicidade negativa

1.2.2.1. Estabelece uma Metodologia

- http://www.isecom.org/osstmm/ The Open Source Security Testing Methodology Manual (OSSTMM)

- http://www.owasp.org/ The Open Web Application Security Project

1.2.3. Avaliando as Ferramentas

1.2.3.1. Escaneando Hosts com o Nmap

1.2.3.1.1. Usando o Nmap

nmap seguido pelo nome do host ou endereço de IP da máquina a ser escaneada.

nmap foo.example.comInteresting ports on foo.example.com: Not shown: 1710 filtered ports PORT STATE SERVICE 22/tcp open ssh 53/tcp open domain 80/tcp open http 113/tcp closed auth

1.2.3.2. Nessus

Nota

1.2.3.3. Nikto

1.2.3.4. Antecipar Suas Futuras Necessidades

1.3. Invasores e Vulnerabilidades

1.3.1. Uma Rápida História sobre Hackers

1.3.1.1. Tons de cinza

1.3.2. Ameaças à Segurança de Rede

1.3.2.1. Arquiteturas Inseguras

1.3.2.1.1. Redes de Transmissão

1.3.2.1.2. Servidores Centralizados

1.3.3. Ameaças à Segurança do Servidor

1.3.3.1. Serviços não usados e Portas Abertas

1.3.3.2. Serviços sem Correção

1.3.3.3. Administração Desatenta

1.3.3.4. Serviços Essencialmente Inseguros

1.3.4. Ameaças à Estação de Trabalho e Segurança no PC doméstico.

1.3.4.1. Senhas Ruins

1.3.4.2. Aplicações Clientes Vulneráveis

1.4. Explorações Comuns e Ataques

Tabela 1.1. Explorações Comuns

| Exploração | Descrição | Notas | |||

|---|---|---|---|---|---|

| Senhas Nulas ou Padrão | Deixar as senhas administrativas em branco ou usar um conjunto de senhas padrões definidas pelo fabricante do produto. Isto é mais comum em hardwares como routers e firewalls, embora alguns serviços aplicados no LInux possam conter senhas de administração padrão (embora o Red Hat Enterprise Linux não é distribuído com eles). |

| |||

| Chaves Compartilhadas Padrão | Serviços seguros as vezes empacotam chaves de segurança padrão para o desenvolvimento ou avaliação para propósitos de testes. Se estas chaves são deixadas como estão e colocadas em um ambiente de produção na Internet, todos os usuários com as mesmas chaves padrões possuem acesso ao recurso de chave compartilhada e qualquer informação confidencial que ele contenha. |

| |||

| IP Spoofing | Uma máquina remota que age como um nó em sua rede local, encontra vulnerabilidades em seus servidores e instala um programa de backdoor (porta-dos-fundos) ou um trojan horse para obter controle sob seus recursos de rede. |

| |||

| Eavesdropping (Interceptação) | Uma coleta dos dados que passam entre dois nós ativos em uma rede, interceptando a conexão entre os dois nós. |

| |||

| Vulnerabilidades de Serviços | Um atacante encontra um defeito ou um furo em um serviço executado sob a Internet; através desta vulnerabilidade, o atacante compromete todo o sistema e qualquer dado que ele possa conter, e pode possivelmente comprometer outros sistemas na rede. |

| |||

| Vulnerabilidades de Aplicativos | Atacantes encontram falhas em desktops e aplicativos de estações de trabalho (tal como clientes de email) e executam códigos arbitrários, implementam trojan horses para comprometimento futuro ou quebra de sistemas. Explorações futuras podem ocorrer se a estação de trabalho comprometida possui privilégios administrativos no resto da rede. |

| |||

| Ataques Denial of Service (DoS) | O atacante ou grupo de atacantes coordenam contra uma rede de uma empresa ou recursos de servidor enviando pacotes não autorizados ao host alvo (tanto o servidor, router ou estação de trabalho). Isto força o recurso a se tornar indisponível para usuários legítimos. |

|

1.5. Atualizações de Segurança

1.5.1. Atualizando Pacotes

Nota

1.5.2. Verificando Pacotes Assinados

/mnt/cdrom, use o seguinte comando para importa-lo ao keyring (um banco de dados de chaves confiáveis no sistema):

rpm --import /mnt/cdrom/RPM-GPG-KEYrpm -qa gpg-pubkey*gpg-pubkey-db42a60e-37ea5438rpm -qi seguido do resultado do comando anterior, como neste exemplo:

rpm -qi gpg-pubkey-db42a60e-37ea5438rpm -K /tmp/updates/*.rpmgpg OK. Se caso não, tenha certeza que está usando a chave pública Red Hat correta e também verificar a fonte do conteúdo. Pacotes que não passam verificações GPG não devem ser instalados, já que podem ter sido alterados por um terceiro.

1.5.3. Instalando Pacotes Assinados

rpm -Uvh /tmp/updates/*.rpmrpm -ivh /tmp/updates/<kernel-package>rpm -e <old-kernel-package>Nota

Importante

1.5.4. Aplicando as Mudanças

Nota

- Aplicativos

- Aplicativos do espaço do usuário são quaisquer programas que podem ser iniciados por um usuário do sistema. Tipicamente, tais aplicativos são usados somente quando um usuário, script ou tarefa automatizada os rodam e estes não persistem por longos períodos de tempo.Uma vez que determinado aplicativo de espaço de usuário é atualizado, pare quaisquer instâncias do aplicativo no sistema e rode o programa de novo para usar a versão atualizada.

- Kernel

- O kernel é o componente de software principal do sistema operacional Red Hat Enterprise Linux. Ele gerencia o acesso à memória, ao processador e aos periféricos e também a todas as tarefas agendadas.Por causa de seu papel central, o kernel não pode ser reiniciado sem também parar o computador. Portanto, uma versão atualizada do kernel não pode ser usada até que o sistema seja reinicializado.

- Bibliotecas Compartilhadas

- Bibliotecas compartilhadas são unidades de códigos, como o

glibc, que são usados por um número de aplicações e serviços. Aplicações utilizando uma biblioteca compartilhada tipicamente carrega o código compartilhado quando a aplicação é inicializada, então quaisquer aplicações usando a biblioteca atualizada deve ser parada e reiniciada.Para determinar quais aplicativos em execução se ligam a uma determinada biblioteca, use o comandolsofcomo no exemplo seguinte:lsof /lib/libwrap.so*Este comando retorna uma lista de todas os programas que usam os TCP Wrappers para controle de acesso ao host. Portanto, qualquer programa listado deve ser parado e reiniciado se o pacotetcp_wrappersestiver atualizado. - Serviços SysV

- Serviços SysV são programas de servidores persistentes iniciados durante o processo de boot. Exemplos de serviços SysV incluem o

sshd,vsftpd, exinetd.Pela razão que estes programas normalmente persistem na memória pelo tempo que a máquina é inicializada, cada serviço de atualização SysV deve ser parado e reiniciado depois que o pacote é atualizado. Isto pode ser feito usando Services Configuration Tool (Ferramenta de Configuração de Serviços) ou se autenticando no shell root e digitando o comando/sbin/serviceconforme no exemplo seguinte:/sbin/service <service-name> restartNo exemplo anterior, substitua o <service-name> com o nome do serviço, como osshd. - Serviços

xinetd - Serviços controlados pelo super serviço

xinetdsomente roda quando há uma conexão ativa. Exemplos de serviços controlados peloxinetdincluem o Telnet, IMAP e POP3.Pela razão que novas instâncias destes serviços são iniciadas peloxinetdcada vez que um novo pedido é recebido, as conexões que ocorrem depois de uma atualização são manuseadas pelo software atualizado. Entretanto se existem conexões ativas no momento que o serviço controlado peloxinetdé atualizado, eles são atendidos pela versão antiga do software.Para terminar as instâncias antigas de um determinado serviço controlado peloxinetd, atualize o pacote para o serviço e então pare todos os processos atualmente em execução. Para determinar se o processo está rodando, use o comandopse então okilloukillallpara parar instâncias atuais do serviço.Por exemplo, se uma errata de segurança dos pacotesimapé lançada, atualize os pacotes e então digite o seguinte comando como root no prompt do shell:ps aux | grep imapEste comando retorna todas sessões ativas do IMAP. Sessões individuais podem então ser terminadas digitando o seguinte comando:kill <PID>Se isto falhar para terminar a sessão, use o seguinte comando então:kill -9 <PID>Nos exemplos anteriores, substitua o <PID> com o número de identificação do processo (encontrado na segunda coluna do comandops) para uma sessão de IMAP.Para terminar todas as sessões IMAP ativas, digite o seguinte comando:killall imapd

Capítulo 2. Protegendo sua Rede

2.1. Segurança da Estação de Trabalho

2.1.1. Avaliando a Segurança da Estação de Trabalho

- Segurança da BIOS e do carregador de Boot — É possível que um usuário não autorizado acesse a máquina fisicamente e inicialize como um usuário único ou modo de recuperação sem uma senha?

- Segurança da Senha — Quão seguros estão as senhas das contas de usuários na máquina?

- Controles Administrativos — Quem possuirá uma conta no sistema e quanto controle administrativo possuirão?

- Serviços de Redes Disponíveis — Quais serviços estão escutando por pedidos da rede e eles deveriam estar rodando?

- Firewalls Pessoais — Qual tipo de firewall seria necessário?

- Ferramentas de Comunicação com Segurança Avançada — Quais ferramentas devem ser usadas para se comunicar entre estações de trabalho e quais deveriam ser evitadas?

2.1.2. Segurança da BIOS e do Carregador de Boot

2.1.2.1. Senhas da BIOS

- Prevenindo Mudanças às Configurações da BIOS — Se um invasor possui acesso à BIOS, ele pode configura-la para fazer o boot de um disquete ou CD-ROM. Sendo possível entrar no modo de recuperação ou modo de usuário único, que permite iniciar processos arbitrários no sistema ou copiar dados sensíveis.

- Prevenindo Inicialização do Sistema — Algumas BIOS permitem proteção por senha do processo de boot. Quando ativados, um invasor é forçado a entrar com uma senha antes que a BIOS inicie o carregador de boot.

2.1.2.1.1. Protegendo Plataformas que não são X86

2.1.2.2. Senhas do Carregador de Boot

- Impedir Acesso ao Modo de Usuário Único — Se invasores podem inicializar o sistema no modo de usuário único, eles são logados automaticamente como root sem serem questionados pela senha root.

- Impedir Acesso ao Console GRUB — Se a máquina usa o GRUB como seu carregador de boot, um invasor pode usar a interface do editor GRUB para mudar sua configuração ou pegar informações usando o comando

cat. - Impedir Acesso à Sistemas Operacionais Inseguros — Se o sistema possui sistema de boot duplo, um invasor pode selecionar um sistema operacional no momento do boot (por exemplo, o DOS), que ignora controles de acesso e permissões de arquivos.

2.1.2.2.1. Protegendo o GRUB com senha

/sbin/grub-md5-crypt/boot/grub/grub.conf. Abra o arquivo e abaixo da linha timeout na seção principal do documento, adicione a seguinte linha:

password --md5 <password-hash>/sbin/grub-md5-crypt[12].

/boot/grub/grub.conf deve ser editada.

title do sistema operacional que você quer proteger e adicione uma linha com a diretiva lock imediatamente embaixo dela.

title DOS lockAtenção

password deve estar presente na seção principal do arquivo /boot/grub/grub.conf para este método para funcionar propriamente. Caso contrário, um invasor pode acessar a interface do editor GRUB e remover a linha bloqueada.

lock à estrofe, seguida pela linha da senha.

title DOS lock password --md5 <password-hash>2.1.3. Segurança da Senha

/etc/passwd, que faz o sistema vulnerável à ataques de quebra de senhas offline. Se um invasor pode ter acesso à máquina como um usuário normal, ele pode copiar o arquivo /etc/passwd para sua própria máquina e rodar quaisquer programas de quebra de senha. Se houver uma senha insegura no arquivo, é somente um questão de tempo até que o invasor a descubra.

/etc/shadow, que pode ser lido somente pelo usuário root.

2.1.3.1. Criando Senhas Fortes

- Não Use Somente Palavras ou Números — Nunca use somente números ou palavras em uma senha.Alguns exemplos inseguros incluem o seguinte:

- 8675309

- juan

- hackme

- Não Use Palavras Reconhecíveis — Palavras como nomes próprios, palavras de dicionário ou mesmo termos de programas de televisão ou novelas devem ser evitados, mesmo se finalizados com números.Alguns exemplos inseguros incluem o seguinte:

- john1

- DS-9

- mentat123

- Não Use Palavras em Línguas Estrangeiras — Programas de quebra de senha muitas vezes tentam listas de palavras que incluem dicionários de muitas línguas. Contar com línguas estrangeiras para senhas não é seguro.Alguns exemplos inseguros incluem o seguinte:

- cheguevara

- bienvenido1

- 1dumbKopf

- Não Use Terminologia Hacker — Se você acha que é elite porque você usa terminologia hacker — também conhecida como a escrita l337 (LEET) — em sua senha, pense novamente. Muitas listas de palavras incluem a escrita LEET.Alguns exemplos inseguros incluem o seguinte:

- H4X0R

- 1337

- Não Use Informações Pessoais — Evite usar qualquer informação pessoal em suas senhas. Se o invasor conhece sua identidade, a tarefa em adivinhar sua senha se torna mais fácil. A seguir está uma lista de tipos de informações a serem evitadas quando criar uma senha:Alguns exemplos inseguros incluem o seguinte:

- Seu Nome

- Nomes de animais de estimação

- Os nomes dos membros da família

- Qualquer data de aniversário

- Seu número de telefone ou código postal

- Não Inverta Palavras Reconhecíveis — Verificadores de senhas bons sempre invertem as palavras comuns, então inverter uma senha fraca não a faz mais segura.Alguns exemplos inseguros incluem o seguinte:

- R0X4H

- nauj

- 9-DS

- Não Escreva Sua Senha — Nunca guarde sua senha em papel. É mais seguro memoriza-la.

- Não Use a Mesma Senha para Todas as Máquinas — É importante fazer senhas separadas para cada máquina. Desta maneira se um sistema é comprometido, todas suas máquinas não estarão imeditatamente em risco.

- Faça a Senha com no Mínimo 8 Dígitos — Quanto mais longa a senha, melhor. Se usar senhas MD5, ela deve ser de 15 ou mais dígitos . Com senha DES, use a extensão máxima (oito caracteres).

- Misture Maiúsculas e Minúsculas — O Red Hat Enterprise Linux diferencia maiúsculas de minúsculas, então misture as letras para aumentar a força da senha.

- Misture Letras e Números — Adicionar números às senhas, especialmente quando adicionados no meio (não só no início ou no final), pode aumentar a força da senha.

- Inclua Caracteres Não Alfa Numéricos — Caracteres especiais como &, $, e > podem melhorar muito a força de uma senha (isto não é possível se usar senhas DES).

- Escolha uma Senha que Você pode se Lembrar — A melhor senha do mundo não faz nada se você não lembra-la; use acrônimos ou outros dispositivos mnemônicos para ajudar a memorizar senhas.

2.1.3.1.1. Metodologia para Criação de Senhas Seguras

- Pense em uma frase fácil de se lembrar, como esse em inglês:"over the river and through the woods, to grandmother's house we go."

- Depois, transforme a frase em um acrônimo (incluindo a pontuação).

otrattw,tghwg. - Adicione complexidade substituindo números e símbolos por letras no acrônimo. Por exemplo, substitua

7pelote o símbolo (@) peloa:o7r@77w,7ghwg. - Adicione mais complexidade colocando em maiúsculo pelo menos uma letra, tal como

H.o7r@77w,7gHwg. - Finalmente, não use o exemplo da senha acima em qualquer sistema, nunca.

2.1.3.2. Criando Senhas de Usuários Dentro de Uma Organização

2.1.3.2.1. Forçando Senhas Fortes

passwd, que é o Pluggable Authentication Modules (PAM) checando se a senha é muito curta ou de outra maneira fácil de quebrar. Esta verificação é realizada usando o modulo PAM pam_cracklib.so. Já que o PAM é personalizável, é possível adicionar mais de um verificador de integridade de senhas, como pam_passwdqc (disponível em http://www.openwall.com/passwdqc/) ou escrever um módulo novo. Para uma lista de módulos PAM disponíveis, consulte o http://www.kernel.org/pub/linux/libs/pam/modules.html. Para mais informações sobre o PAM, consulte Gerenciando Sign-On Únicos e Cartões Smart.

- John The Ripper — Um rápido de flexível programa de quebra de senhas. Permite o uso de múltiplas listas de palavras e é capaz de quebrar senhas por força bruta. Está disponível online em http://www.openwall.com/john/.

- Crack — Talvez o mais conhecido programa de quebra de senhas, o Crack é também muito rápido, embora não tão fácil de usar como o John The Ripper. Pode ser encontrado em http://www.crypticide.com/alecm/security/crack/c50-faq.html.

- Slurpie — O Slurpie é similar ao John The Ripper e o Crack, mas é desenhado para rodar em múltiplos computadores simultaneamente, criando um ataque de quebra de senhas distribuído. Ele pode ser encontrado online junto com uma série de outras ferramentas de avaliação de ataque à segurança em http://www.ussrback.com/distributed.htm.

Atenção

2.1.3.2.2. Frases Secretas

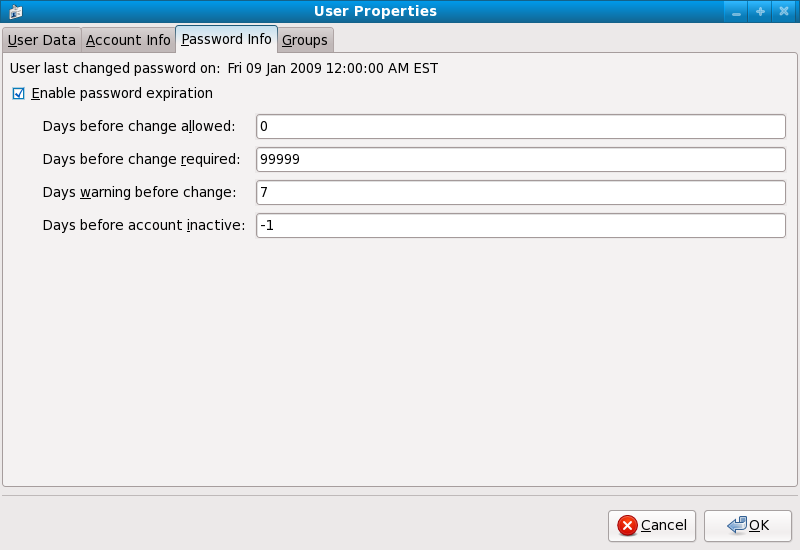

2.1.3.2.3. Expiração de Senha

chage ou a aplicação User Manager (system-config-users).

-M do comando chage especifica o número máximo de dias que a senha é válida. Por exemplo, para definir que a senha de um usuário expire em 90 dias, use o seguinte comando:

chage -M 90 <username>99999 depois da opção -M (isto é equivale a mais ou menos 273 anos).

chage em modo interativo para modificar múltiplas expirações de senhas e detalhes de conta. Use o comando seguinte para entrar no modo interativo:

chage <username>[root@myServer ~]# chage davido Changing the aging information for davido Enter the new value, or press ENTER for the default Minimum Password Age [0]: 10 Maximum Password Age [99999]: 90 Last Password Change (YYYY-MM-DD) [2006-08-18]: Password Expiration Warning [7]: Password Inactive [-1]: Account Expiration Date (YYYY-MM-DD) [1969-12-31]: [root@myServer ~]#

- Clique no menu System (Sistema) no painel, depois em Administration (Administração) e então clique em Users and Groups (Usuários e Grupos) para exibir o Gerenciador de Usuários. Alternativamente, digite o comando

system-config-usersno shell. - Clique na aba Users (Usuários) e selecione o usuário requerido na lista de usuários.

- Clique em Properties (Propriedades) na barra de ferramentas para exibir as caixa de diálogo das Propriedades do Usuário (ou escolha Properties (Propriedades) no menu File (Arquivo)).

- Clique na aba Password Info (Informações de Senha) e marque a caixa de verificação Enable password expiration (Ativar expiração de senha).

- Digite o valor requerido no campo Days before change required (Dias antes da mudança requerida) e clique OK.

Figura 2.1. Especificando as opções de expiração de senha

2.1.4. Controles Administrativos

sudo ou su. Um programa setuid é um que opera com a ID de usuário (UID) do proprietário do programa em vez do usuário operar o programa. Tais programas são denotados por um s na seção proprietário de uma lista de formato longo, como no exemplo a seguir:

-rwsr-xr-x 1 root root 47324 May 1 08:09 /bin/suNota

s pode ser maiúsculo ou minusculo. Se aparecer como maiúsculo, significa que o bit de permissão subjacente não foi definido.

pam_console.so, algumas atividades normalmente reservadas somente para o usuário root, como reinicialização e montagem de mídia removíveis são permitidas para o primeiro usuário que logar no console físico (consulte Gerenciando Sign-On Únicos e Cartões Smart para mais informações sobre o módulo pam_console.so). Entretanto, outras tarefas importantes de administração do sistema, como alterar definições de rede, configurar um mouse novo ou montar dispositivos de rede não são possíveis sem privilégios administrativos. Como resultado, administradores de sistema devem decidir quanta acessibilidade os usuários em sua rede devem receber.

2.1.4.1. Permitindo Acesso Root

- Desconfiguração da Máquina — Usuários com acesso root pode desconfigurar suas máquinas e necessitar de assistência para resolver o problema. Ainda pior, eles podem abrir brechas de segurança sem perceber.

- Executando Serviços Inseguros — Usuários com acesso root podem rodar servidores inseguros em suas máquinas, como FTP ou Telnet, colocando nomes de usuários e senhas potencialmente em risco. Estes serviços transmitem estas informações pela a rede em texto puro.

- Executar Anexos de Email como Root — Ainda que raro, vírus em e-mails que afetam o Linux existem. O único momento entretanto que eles são uma ameaça é quando eles são executados pelo usuário root.

2.1.4.2. Desabilitando Acesso ao Root

Tabela 2.1. Métodos para Desabilitar a Conta Root

| Método | Descrição | Efeitos | Não afeta | |||||||||||||||

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| Alternado o shell do root. | Edite o arquivo /etc/passwd e mude o shell de /bin/bash para /sbin/nologin. |

|

| |||||||||||||||

| Desativar o acesso root por qualquer dispositivo de console (tty). | Um arquivo /etc/securetty impede o login de root em quaisquer dispositivos anexados ao computador. |

|

| |||||||||||||||

| Desativando logins root SSH. | Edite o arquivo /etc/ssh/sshd_config e defina o parâmetro PermitRootLogin para no. |

|

| |||||||||||||||

| Use o PAM para limitar acesso root aos serviços. | Edite o arquivo para o serviço alvo no diretório /etc/pam.d/. Tenha certeza que o pam_listfile.so é requerido para autenticação. [a] |

|

| |||||||||||||||

[a]

Consulte a Seção 2.1.4.2.4, “Desativando o Root de usar o PAM” para detalhes.

| ||||||||||||||||||

2.1.4.2.1. Desativando o Shell do Root

/sbin/nologin no arquivo /etc/passwd. Isso impede o acesso à conta root através de comando que requerem um shell, como os comandos su e o ssh

Importante

sudo, podem ainda acessar a conta root.

2.1.4.2.2. Desativando Logins Root

/etc/securetty. Este arquivo lista todos os dispositivos em que o usuário root é permitido logar. Se o arquivo não existir, o usuário root pode se autenticar através de qualquer dispositivo de comunicação no sistema, seja pelo console ou uma interface de rede bruta. Isto é perigoso, porque um usuário pode se autenticar em sua máquina pela rede. Por padrão, o arquivo /etc/securetty do Red Hat Enterprise Linux somente permite ao usuário root se autenticar no console fisicamente anexado à máquina. Para impedir o root de se autenticar, remova o conteúdo deste arquivo, digitando o seguinte comando:

echo > /etc/securettyAtenção

/etc/securetty não impede o usuário root de se autenticar remotamente usando a suíte de ferramentas OpenSSH porque o console não é aberto até depois da autenticação.

2.1.4.2.3. Desativando Logins Root SSH

/etc/ssh/sshd_config). Mude a linha que contém:

PermitRootLogin yesPermitRootLogin nokill -HUP `cat /var/run/sshd.pid`2.1.4.2.4. Desativando o Root de usar o PAM

/lib/security/pam_listfile.so, permite uma grande flexibilidade em negar contas específicas. O administrador pode usar este módulo para referenciar uma lista de usuários que não estão permitidos de se autenticar. Abaixo está um exemplo de como o módulo é usado pelo servidor FTP vsftpd no arquivo de configuração do PAM /etc/pam.d/vsftpd, o caractere \ no final da primeira linha no exemplo seguinte não é necessário se a diretiva está em uma linha):

auth required /lib/security/pam_listfile.so item=user \ sense=deny file=/etc/vsftpd.ftpusers onerr=succeed

/etc/vsftpd.ftpusers e negar acesso ao serviço para qualquer usuário listado. O administrador pode mudar o nome deste arquivo e manter listas separadas para cada serviço ou usar uma lista central para negar acesso à múltiplos serviços.

/etc/pam.d/pop e o /etc/pam.d/imap para clientes de e-mail ou o /etc/pam.d/ssh para cliente SSH.

2.1.4.3. Limitando o Acesso Root

su ou sudo.

2.1.4.3.1. O Comando su

su, ele é questionado pela senha root e depois da autenticação, recebe a linha de comando do root.

su, o usuário se torna o usuário root e possui acesso administrativo absoluto ao sistema[13]. Além disso, uma vez que um usuário se tornou root, é possível para ele usar o comando su para mudar para qualquer outro usuário no sistema sem ser questionado por uma senha.

usermod -G wheel <username>wheel.

- Clique no menu System (Sistema) no painel, depois em Administration (Administração) e então clique em Users and Groups (Usuários e Grupos) para exibir o Gerenciador de Usuários. Alternativamente, digite o comando

system-config-usersno shell. - Clique na aba Users (Usuários) e selecione o usuário requerido na lista de usuários.

- Clique em Properties (Propriedades) na barra de ferramentas para exibir as caixa de diálogo das Propriedades do Usuário (ou escolha Properties (Propriedades) no menu File (Arquivo)).

- Clique na aba Groups (Grupos), marque a caixa de seleção para o grupo wheel, e então clique em OK. Veja a Figura 2.2, “Adicionando usuários ao grupo "wheel".”

Figura 2.2. Adicionando usuários ao grupo "wheel".

su (/etc/pam.d/su) em um editor de textos e remova o comentário # na seguinte linha:

auth required /lib/security/$ISA/pam_wheel.so use_uid

wheel podem usar este programa.

Nota

wheel por padrão.

2.1.4.3.2. O Comando sudo

sudo oferece outra abordagem para dar aos usuários o acesso administrativo. Quando usuários confiáveis precedem um comando administrativo com o sudo, eles são questionados pela própria senha. Então, quando eles são autenticados e assumindo que o comando é permitido, o comando administrativo é executado como se ele fosse o usuário root.

sudo é como a seguir:

sudo <command>mount.

Importante

sudo devem ter cuidade e sair do comando antes de deixar a máquina, já que o sudo pode executar o comando novamente sem ter a senha pedida dentro de um período de cinco minutos. Esta configuração pode ser alterada pelo arquivo de configuração, /etc/sudoers.

sudo permite um alto grau de flexibilidade. Por exemplo, somente usuários listados no arquivo de configuração /etc/sudoers são permitidos usar o comando sudo e o comando é executado no shell do usuário, não no shell do root. Isto significa que o shell do root pode ser completamente desativado, como mostrado na Seção 2.1.4.2.1, “Desativando o Shell do Root”.

sudo também fornece um registro de auditoria abrangente. Cada autenticação feita é registrada no arquivo /var/log/messages e o comando digitado junto com o nome do usuário é registrado no arquivo /var/log/secure.

sudo é que um administrador pode permitir usuários diferentes acessar comandos especificos baseados em suas necessidades.

sudo, /etc/sudoers, devem usar o comando visudo.

visudo e adicione uma linha similar à seguinte na seção de especificação de privilégio do usuário:

juan ALL=(ALL) ALLjuan, pode usar sudo de qualquer host e executar qualquer comando.

sudo:

%users localhost=/sbin/shutdown -h now/sbin/shutdown -h now desde que ele seja emitido a partir do console.

sudo possui uma lista detalhada de opções para este arquivo.

2.1.5. Serviços de Rede Disponíveis

2.1.5.1. Riscos ao Serviços

- Denial of Service Attacks (DoS) — Inunda um serviço com pedidos, um ataque de negação de serviço pode fazer um sistema inutilizável conforme ele tenta registrar e responder cada pedido.

- Distributed Denial of Service Attack (DDoS) — Um tipo de ataque DoS que usa múltiplas máquinas comprometidas (muitas vezes milhares ou mais) para direcionar um ataque coordenado à um serviço, inundando com pedidos e fazendo o serviço inutilizável.

- Script Vulnerability Attacks — Se um servidor estiver usando scripts para executar ações dentro do servidor, como servidores web geralmente fazem, um invasor pode atacar os scripts impropriamente. Estes ataques de vulnerabilidade de script podem levar à uma condição de buffer overflow ou permitir ao invasor alterar arquivos no sistema.

- Buffer Overflow Attacks — Serviços que conectam às portas numeradas de 0 a 1023 devem rodar como um usuário administrativo. Se a aplicação tiver um buffer overflow explorável, um invasor poderia ganhar acesso ao sistema como o usuário executando o deaemon. Pela razão que buffer overflow existe, os crackers usam ferramentas automatizadas para identificar sistemas com vulnerabilidades e uma vez que ganharam acesso, eles usam rootkits automatizados para manter o acesso ao sistema.

Nota

Importante

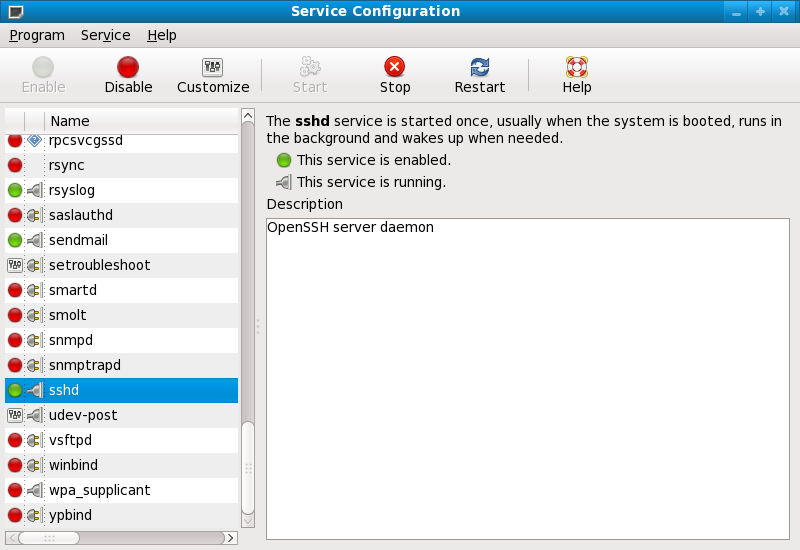

2.1.5.2. Identificando e Configurando Serviços

cupsd— O servidor de impressão do Red Hat Enterprise Linux.lpd— Um servidor de impressão alternativo.xinetd— Um super servidor que controla conexões de uma variedade de servidores subordinados, tais comogssftpetelnet.sendmail— O Sendmail Mail Transport Agent (MTA) é ativado por padrão, mas somente escuta por conexões do localhost.sshd— O servidor OpenSSH que é um substituto seguro para o Telnet.

cupsd rodando. O mesmo é verdadeiro para o portmap. Se você não montar os volumes NFSv3 ou usar o NIS (o serviço ypbind), então o portmap deve ser desativado.

Figura 2.3. Ferramentas de Configuração de Serviços

2.1.5.3. Serviços Inseguros

- Transmitir Nomes de Usuários e Senhas Sobre uma Rede Sem Encriptação — Muitos protocolos antigos, como Telnet e FTP não fazem encriptação da sessão de autenticação e deveriam ser evitados sempre que possível.

- Transmitir Dados Sensíveis Sobre uma Rede Sem Encriptação — Muitos protocolos transmitem dados sobre uma rede sem encriptação. Estes protocolos incluem Telnet, FTP, HTTP e SMTP. Muitos sistemas de arquivos de rede, como NFS e SMB também transmitem informações sobre a rede sem encriptação. É a responsabilidade do usuário limitar quais tipos de dados são transmitidos quando usar estes protocolos.Serviços de Dump de Memória Remota, como o

netdump, transmitem os conteúdos de memória sobre a rede sem encriptação. Dumps de memória podem conter senhas ou, ainda pior, entradas de banco de dados e outras informações sensíveis.Outros serviços como ofingererwhodrevelam informações sobre os usuários do sistema.

rlogin, rsh, telnet e vsftpd.

rlogin, rsh, e telnet) devem ser evitados em favor do SSH. Consulte a Seção 2.1.7, “Ferramentas de Comunicação Avançadas de Segurança” para mais informações sobre o sshd.

fingerauthd(este era chamadoidentdem versões anteriores do Red Hat Enterprise Linux.)netdumpnetdump-servernfsrwhodsendmailsmb(Samba)yppasswddypservypxfrd

2.1.6. Firewalls Pessoais

Importante

system-config-firewall) . Esta ferramenta cria regras abrangentes de iptables para um firewall de uso geral usando uma interface de painel de controle.

iptables é provavelmente a melhor opção. Consulte a Seção 2.5, “Firewalls” para mais informações. Consulte a Seção 2.6, “IPTables” para um guia compreensivo do comando iptables.

2.1.7. Ferramentas de Comunicação Avançadas de Segurança

- OpenSSH — Uma implementação grátis do protocolo SSH para encriptação de comunicação de rede.

- Gnu Privacy Guard (GPG) — Uma implementação grátis da aplicação de encriptação PGP (Pretty Good Privacy) para dados.

telnet e rsh. O OpenSSH inclui um serviço de rede chamado sshd e três aplicações clientes de linha de comando:

ssh— Um cliente de acesso remoto de console seguro.scp— Um comando de cópia remota seguro.sftp— Um cliente de pseudo ftp seguro que permite sessões de transferência de arquivos seguros.

Importante

sshd ser inerentemente seguro, o serviço deve ser mantido atualizado para impedir ameaças de segurança. Consulte a Seção 1.5, “Atualizações de Segurança” para mais informações.

2.2. Segurança do Servidor

- Mantém todos os serviços atualizados, para protege-los contra as últimas ameaças.

- Use protocolos seguros sempre que possível.

- Sirva somente um tipo de serviço de rede por máquina sempre que possível.

- Monitore todos os servidores cuidadosamente por atividades suspeitas.

2.2.1. Assegure os Serviços com TCP Wrappers e xinetd

xinetd, um super servidor que fornece acesso adicional, registro de logs, associação, redirecionamento e controle de utilização de recursos.

Nota

xinetd para criar redundância dentro dos controles de acesso de serviço. Consulte a Seção 2.5, “Firewalls” para mais informações sobre implementar firewalls com comandos iptables.

2.2.1.1. Aumentando a Segurança com TCP Wrappers

hosts_options para informações sobre a funcionalidade dos TCP Wrappers e idioma de controle. Consulte a página man xinetd.conf disponível online em http://linux.die.net/man/5/xinetd.conf para os sinalizadores disponíveis, que agem como opções que você pode aplicar em um serviço.

2.2.1.1.1. TCP Wrappers e Banners de Conexão

banner.

vsftpd. Para iniciar, crie um arquivo de banner. Ele pode estar em qualquer lugar no sistema, mas ele deve ter o mesmo nome como o daemon. Para este exemplo, este arquivo é chamado /etc/banners/vsftpd e contém a seguinte linha:

220-Hello, %c 220-All activity on ftp.example.com is logged. 220-Inappropriate use will result in your access privileges being removed.

%c fornece uma variedade de informações sobre o cliente, tais como o nome de usuário e hostname ou nome de usuário e endereço de IP para fazer a conexão ainda mais intimidadora.

/etc/hosts.allow:

vsftpd : ALL : banners /etc/banners/ 2.2.1.1.2. TCP Wrappers e Avisos de Ataques

spawn.

/etc/hosts.deny para negar quaisquer tentativas de conexão dessa rede, e registrar as tentativas em log em um arquivo especial:

ALL : 206.182.68.0 : spawn /bin/echo `date` %c %d >> /var/log/intruder_alert %d fornece o nome do serviço que o invasor estava tentando acessar.

spawn no arquivo /etc/hosts.allow.

Nota

spawn executa qualquer comando shell, é uma boa idéia criar um script especial para notificar o administrador ou executar uma cadeia de comandos no evento de um determinado cliente tentar se conectar ao servidor.

2.2.1.1.3. Os TCP Wrappers e Registro de Log Avançado

severity.

emerg nos arquivos de log em vez do sinalizador padrão, info e negue a conexão.

/etc/hosts.deny:

in.telnetd : ALL : severity emerg authpriv, mas eleva a prioridade do valor padrão de info para emerg, que posta mensagens de log diretamente ao console.

2.2.1.2. Aumentando a Segurança com o xinetd

xinetd para definir um serviço de interceptação (trap) e usa-lo para controlar os níveis de recursos disponíveis para qualquer serviço xinetd dado. Definindo limites de recursos disponíveis para serviços pode ajudar impedir ataques DoS (Denial of Service ). Consulte as páginas man do xinetd e do xinetd.conf para uma lista de opções disponíveis.

2.2.1.2.1. Configurando uma Interceptação (Trap)

xinetd é sua habilidade de adicionar hosts à uma lista no_access global. Hosts nesta lista são conexões subsequentes negadas a serviços gerenciados pelo xinetd por um período especificado ou até que o xinetd seja reiniciado. Você pode fazer isto usando o atributo SENSOR. Esta é uma fácil maneira de bloquear hosts tentando escanear as portas neste servidor.

SENSOR é escolher um serviço que você não planeja usar. Para este exemplo, o Telnet é usado.

/etc/xinetd.d/telnet e mude as linhas das flags (sinalizadores) para:

flags = SENSOR

deny_time = 30

deny_time são o FOREVER, que mantém o banimento em efeito até que o xinetd seja reiniciado, e o NEVER, que permite a conexão e registra isso em log.

disable = no

SENSOR é uma boa maneira para detectar e parar conexões de hosts indesejáveis, ela possui desvantagens:

- Não funciona contra escaneamentos stealth.

- Um invasor que sabe que o

SENSORestá rodando pode montar um ataque Dos (Denial of Service) contra determinados hosts, falsificando seus endereços IP e se conectando à porta proibida.

2.2.1.2.2. Controlando Recursos de Servidor

xinetd é a habilidade de configurar limites de serviços sobre seu controle.

cps = <number_of_connections> <wait_period>— Limita a taxa de conexões de entrada. Esta diretiva leva dois argumentos:<number_of_connections>— O número de conexões por segundo para manuseio. Se a taxa de conexões de entrada é maior que isso, o serviço é temporariamente desativado. O valor padrão é cinquenta (50).<wait_period>— O número de segundos para esperar antes da reativação do serviço depois que ele foi desativado. O intervalo padrão é dez (10) segundos.

instances = <number_of_connections>— Especifica o número total de conexões permitidas a um serviço. Esta diretiva aceita tanto um valor de número inteiro ouUNLIMITED(ilimitado).per_source = <number_of_connections>— Especifica o número de conexões permitidas a um serviço por cada host. Esta diretiva aceita tanto um valor de número ouUNLIMITED(ilimitado).rlimit_as = <number[K|M]>— Especifica a quantidade de espaço de endereço de memória que o serviço pode ocupar em kilobytes ou megabytes. Esta diretiva aceita tanto um valor de número inteiro ouUNLIMITED.rlimit_cpu = <number_of_seconds>— Especifica o período de tempo em segundos que um serviço pode ocupar na CPU. Esta diretiva aceita tanto um integrador de número inteiro ouUNLIMITED(limitado).

xinetd único de sobrecarregar o sistema, resultando em um DoS (denial of service).

2.2.2. Protegendo o Portmap

portmap é um daemon de atribuição de porta dinâmica para serviços RPC como NIS e NFS. Ele possui uma mecanismo de autenticação fraco e possui a habilidade de atribuir uma grande variedade de portas para os serviços que controla. Por estas razões, ele é difícil de proteger.

Nota

portmap somente afeta as implementações NFSv2 e NFSv3, já que o NFSv4 não o requer mais. Se você planeja implementar um servidor NFSv2 ou NFSv3, então o portmap é requerido e as seguintes seções se aplicam.

2.2.2.1. Proteja o portmap com TCP Wrappers

portmap desde que ele não possua uma forma de autenticação embutida.

2.2.2.2. Proteger o portmap com o iptables

portmap, é uma boa idéia adicionar regras de iptables ao servidor e restringir acesso às redes especificas.

portmap) da rede 192.168.0.0/24. A segunda permite conexões TCP à mesma porta do local host. Isto é necessário para o serviço sgi_fam usado pelo Nautilus. Todos os outros pacotes são largados.

iptables -A INPUT -p tcp ! -s 192.168.0.0/24 --dport 111 -j DROP iptables -A INPUT -p tcp -s 127.0.0.1 --dport 111 -j ACCEPT

iptables -A INPUT -p udp ! -s 192.168.0.0/24 --dport 111 -j DROP

Nota

2.2.3. Protegendo o NIS

ypserv, que é usado em conjunto com o portmap e outros serviços relacionados para distribuir mapas de nomes de usuários, senhas e outras informações sensíveis a qualquer computador alegando estar dentro do domínio.

/usr/sbin/rpc.yppasswdd— Também chamado serviçoyppasswdd, este daemon permite usuários alterar suas senhas NIS./usr/sbin/rpc.ypxfrd— Também chamado serviçoypxfrd, este daemon é responsável por transferências de mapas NIS pela rede./usr/sbin/yppush— Esta aplicação propaga bancos de dados NIS para múltiplos servidores NIS./usr/sbin/ypserv— Este é o daemon do servidor NIS.

portmap conforme descrito na Seção 2.2.2, “Protegendo o Portmap”, em seguida, aborde as seguintes questões, como planejar a rede.

2.2.3.1. Planeje a Rede Cuidadosamente

2.2.3.2. Use um Nome de Domínio NIS e Hostname como se fosse uma Senha.

/etc/passwd:

ypcat -d <NIS_domain> -h <DNS_hostname> passwd

/etc/shadow digitando o seguinte comando:

ypcat -d <NIS_domain> -h <DNS_hostname> shadow

Nota

/etc/shadow não é armazenado dentro de um mapa NIS.

o7hfawtgmhwg.domain.com. Da mesma maneira, crie um nome de domínio NIS aleatório diferente. Isto deixa mais difícil para um invasor acessar o servidor NIS.

2.2.3.3. Edite o Arquivo /var/yp/securenets

/var/yp/securenets está em branco ou não existe (como é o caso depois da instalação padrão), o NIS escuta todas as redes. Uma das primeiras coisas a fazer é colocar os pares de mascara de rede/rede no arquivo para que o ypserv somente responda aos pedidos da rede apropriada.

/var/yp/securenets:

255.255.255.0 192.168.0.0

Atenção

/var/yp/securenets.

2.2.3.4. Atribua Portas Estáticas e Use Regras iptables

rpc.yppasswdd — o daemon que permite usuários mudar suas senhas de login. Atribuir portas aos outros dois daemons do servidor NIS rpc.ypxfrd and ypserv, permite a criação de regras de firewall para proteger ainda mais o daemons do servidor NIS de invasores.

/etc/sysconfig/network:

YPSERV_ARGS="-p 834" YPXFRD_ARGS="-p 835"

iptables -A INPUT -p ALL ! -s 192.168.0.0/24 --dport 834 -j DROP iptables -A INPUT -p ALL ! -s 192.168.0.0/24 --dport 835 -j DROP

Nota

2.2.3.5. Use a Autenticação Kerberos

/etc/shadow é enviado pela rede. Se um invasor ganha acesso a um domínio NIS e intercepta o tráfego de rede, ele pode coletar nomes de usuários e senhas hash. Com tempo suficiente, um programa de quebra de senha pode adivinhar senhas fracas e um invasor pode ter acesso a uma conta válida na rede.

2.2.4. Protegendo o NFS

Importante

portmap conforme explicado na Seção 2.2.2, “Protegendo o Portmap”. O tráfego de NFS agora utiliza o TCP em todas as versões, em vez do UDP, e requer isso quando usar o NFSv4. O NFSv4 agora inclui o usuário Kerberos e a autenticação de grupo como parte do módulo do kernel RPCSEC_GSS. Informações sobre o portmap é ainda incluída, desde que o Red Hat Enterprise Linux 6 suporta o NFSv2 e o NFSv3, e ambos utilizam o portmap.

2.2.4.1. Planeje a Rede Cuidadosamente

2.2.4.2. Atenção aos Erros de Sintaxe

/etc/exports. Cuidado para não adicionar espaços fora de lugar quando editar este arquivo.

/etc/exports compartilha o diretório /tmp/nfs/ ao host bob.example.com com permissões de leitura/escrita.

/tmp/nfs/ bob.example.com(rw)

/etc/exports, por outro lado, compartilha o mesmo diretório do host bob.example.com com permissões de leitura somente e compartilha com o world com permissões de leitura/escrita devido ao carácter espaço único depois do hostname.

/tmp/nfs/ bob.example.com (rw)

showmount para verificar o que está sendo compartilhado:

showmount -e <hostname>

2.2.4.3. Não Use a Opção no_root_squash

nfsnobody, uma conta de usuário sem previlégios. Isto muda o proprietário de todos os arquivos criados pelo root para nfsnobody, que impede o upload de programas com o setuid definido.

no_root_squash é usado, os usuários root remotos são capazes de mudar quaisquer arquivos no sistema de arquivos compartilhados e deixar aplicações infectadas por trojans para que outros usuários as executem sem saber.

2.2.4.4. Configuração de Firewall NFS

MOUNTD_PORT— Porta UDP e TCP para o mountd (rpc.mountd)STATD_PORT— Porta UDP e TCP para o status (rpc.statd)LOCKD_TCPPORT— Porta TCP para o nlockmgr (rpc.lockd)LOCKD_UDPPORT— Porta UDP para o nlockmgr (rpc.lockd)

rpcinfo -p no servidor NFS para ver quais portas e programas RPC estão sendo usados.

2.2.5. Protegendo o Servidor HTTP Apache

chown root <directory_name>

chmod 755 <directory_name>

/etc/httpd/conf/httpd.conf):

FollowSymLinks- Esta diretiva está ativada por padrão, então seja cauteloso quando criar links simbólicos ao documento root do Servidor Web. Por exemplo, não é uma boa idéia fornecer um link simbolico para o

/. Indexes- Esta diretiva está ativada por padrão, mas pode não ser desejável. Para impedir visitantes de navegar pelos arquivos do servidor, remova esta diretiva.

UserDir- A diretiva

UserDirestá desativada por padrão por causa que ela pode confirmar a presença de uma conta de usuário no sistema. Para ativar a navegação de diretórios no servidor, use as seguintes diretivas:UserDir enabled UserDir disabled root

Estas diretivas ativam a navegação de diretórios de usuários para todos os diretórios de usuários menos o/root/. Para adicionar usuários na lista de contas desativadas, adicione um lista separada por espaços dos usuários na linhaUserDir disabled.

Importante

IncludesNoExec. Por padrão, o módulo Server-Side Includes (SSI) não pode executar comandos. É recomendado que você não mude estas definições a menos que seja absolutamente necessário, já que poderia potencialmente ativar um invasor para executar comandos no sistema.

2.2.6. Protegendo o FTP

gssftpd— Um daemon de FTP baseado emxinetde atento ao Kerberos que não transmite informações de autenticação na rede.- Red Hat Content Accelerator (

tux) — Um servidor Web do kernel com capacidades de FTP. vsftpd— Um implementação orientada à segurança, autônoma do serviço de FTP.

vsftpd

2.2.6.1. Banner de Saudação do FTP

vsftpd, adicione a seguinte diretiva ao arquivo /etc/vsftpd/vsftpd.conf:

ftpd_banner=<insert_greeting_here>

/etc/banners/. O arquivo de banner para conexões FTP neste exemplo é o /etc/banners/ftp.msg. Abaixo está um exemplo de como o arquivo deve ser:

######### # Hello, all activity on ftp.example.com is logged. #########

Nota

220 como especificado na Seção 2.2.1.1.1, “TCP Wrappers e Banners de Conexão”.

vsftpd, adicione a seguinte diretiva ao arquivo /etc/vsftpd/vsftpd.conf:

banner_file=/etc/banners/ftp.msg

2.2.6.2. Acesso Anônimo

/var/ftp/ ativa a conta anônima.

vsftpd. Este pacote estabelece uma árvore de diretórios para usuários anônimos e configura as permissões nos diretórios para somente leitura para os usuários anônimos.

Atenção

2.2.6.2.1. Upload Anônimo

/var/ftp/pub/.

mkdir /var/ftp/pub/upload

chmod 730 /var/ftp/pub/upload

drwx-wx--- 2 root ftp 4096 Feb 13 20:05 upload

Atenção

vsftpd, adicione a seguinte linha ao arquivo /etc/vsftpd/vsftpd.conf:

anon_upload_enable=YES

2.2.6.3. Contas de Usuários

vsftpd, adicione a seguinte diretiva ao /etc/vsftpd/vsftpd.conf:

local_enable=NO

2.2.6.3.1. Restringindo Contas de Usuários

sudo, a maneira mais fácil para usar um arquivo de lista PAM conforme descrito na Seção 2.1.4.2.4, “Desativando o Root de usar o PAM”. O arquivo de configuração PAM para o vsftpd é /etc/pam.d/vsftpd.

vsftpd, adicione o nome de usuário ao /etc/vsftpd/ftpusers

2.2.6.4. Usar o TCP Wrappers para Controla Acesso

2.2.7. Protegendo o Sendmail

2.2.7.1. Limitando um DoS (Denial of Service Attack)

/etc/mail/sendmail.mc, a efetividade do tais ataques é limitada.

confCONNECTION_RATE_THROTTLE— O número de conexões que o servidor pode receber por segundo. Por padrão, o Sendmail não limita o número de conexões. Se um limite é definido e alcançado, as próximas conexões são atrasadas.confMAX_DAEMON_CHILDREN— O número máximo de processos filhos que podem ser gerados pelo servidor. Por padrão, o Sendmail não atribui um limite ao número de processos filhos. Se um limite é definido e alcançado, as próximas conexões são atrasadas.confMIN_FREE_BLOCKS— O número mínimo de blocos livres que devem estar disponíveis para o servidor para aceitar mail. O padrão é 100 blocos.confMAX_HEADERS_LENGTH— O tamanho máximo aceitável (em bytes) para um cabeçalho de mensagens.confMAX_MESSAGE_SIZE— O tamanho máximo aceitável (em bytes) para uma mensagem única.

2.2.7.2. O NFS e Sendmail

/var/spool/mail/, em um volume NFS compartilhado.

Nota

SECRPC_GSS não utiliza uma autenticação baseada em UID. Entretanto, é ainda considerado uma boa prática não colocar o diretório de mail spool em volumes NFS não compartilhados.

2.2.7.3. Usuários somente de Mail

/etc/passwd devem ser definidos para /sbin/nologin (com a exceção possível do usuário root).

2.2.8. Verificando Quais Portas Estão Escutando

netstat -an ou lsof -i. Este método é menos confiável desde que estes programas não se conectam à máquina a partir da rede, mas é melhor verificar para ver o que está rodando no sistema. Por esta razão, estas aplicações são alvos frequentes de substituições por invasores. Crackers tentam cobrir seus rastros se eles abrirem portas de rede não autorizadas substituindo o netstat e o lsof com suas próprias, versões modificadas.

nmap.

nmap -sT -O localhost

Starting Nmap 4.68 ( http://nmap.org ) at 2009-03-06 12:08 EST Interesting ports on localhost.localdomain (127.0.0.1): Not shown: 1711 closed ports PORT STATE SERVICE 22/tcp open ssh 25/tcp open smtp 111/tcp open rpcbind 113/tcp open auth 631/tcp open ipp 834/tcp open unknown 2601/tcp open zebra 32774/tcp open sometimes-rpc11 Device type: general purpose Running: Linux 2.6.X OS details: Linux 2.6.17 - 2.6.24 Uptime: 4.122 days (since Mon Mar 2 09:12:31 2009) Network Distance: 0 hops OS detection performed. Please report any incorrect results at http://nmap.org/submit/ . Nmap done: 1 IP address (1 host up) scanned in 1.420 seconds

portmap por causa da presença do serviço sunrpc . Entretanto, há também um serviço misterioso na porta 834. Para checar se a porta é associada com o a lista oficial de serviços conhecidos, digite:

cat /etc/services | grep 834

netstat ou lsof. Para verificar pela porta 834 usando o netstat, use o seguinte comando:

netstat -anp | grep 834

tcp 0 0 0.0.0.0:834 0.0.0.0:* LISTEN 653/ypbind

netstat é animadora por causa que se um cracker abrir uma porta clandestinamente em um sistema hackeado, não é susceptível de permitir que esta seja revelada através deste comando. Também, a opção [p] revela o ID do processo (PID) do serviço que abriu a porta. Neste caso, a porta aberta pertence ao ypbind (NIS), que é um serviço RPC manuseado em conjunto com o serviço portmap.

lsof revela informações similares ao netstat já que ele é também capaz de ligar portas abertas à serviços:

lsof -i | grep 834

ypbind 653 0 7u IPv4 1319 TCP *:834 (LISTEN) ypbind 655 0 7u IPv4 1319 TCP *:834 (LISTEN) ypbind 656 0 7u IPv4 1319 TCP *:834 (LISTEN) ypbind 657 0 7u IPv4 1319 TCP *:834 (LISTEN)

lsof, netstat, nmap, e services para mais informações.

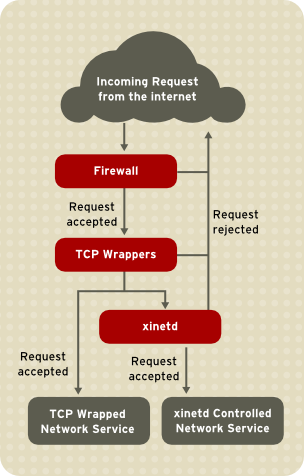

2.3. TCP Wrappers e xinetd

iptables filtra pacotes de rede indesejados dentro da pilha de rede do kernel. Para serviços de rede que os utilizam, os TCP Wrappers adicionam uma camada a mais de proteção definindo quais hosts são ou não são permitidos conectar aos serviços de rede "envolvidos (wrapped)". Um tipo de serviço de rede wrapped é o xinetd super server. O serviço é chamado super server porque ele controla conexões de um subconjunto de serviços de rede e refina ainda mais o controle de acesso.

Figura 2.4. Controle de Acesso para Serviços de Rede

xinetd no controle de acesso aos serviços de rede e revisa como estas ferramentas podem ser usadas para melhorar tanto a autenticação e gerenciamento de utilização. Consulte a Seção 2.6, “IPTables” para informações sobre usar firewalls com iptables.

2.3.1. TCP Wrappers

tcp_wrappers e tcp_wrappers-libs) são instalados por padrão e fornecem controle de acesso baseado no host para serviços de rede. O componente mais importante do pacote é a biblioteca /lib/libwrap.a ou /lib64/libwrap.a. Em termos gerais, um serviço TCP wrapped é um que foi compilado para a biblioteca libwrap.a.

/etc/hosts.allow e /etc/hosts.deny) para determinar se o cliente é permitido ou não se conectar. Na maioria dos casos, ele então usa o syslog daemon (syslogd) para gravar o nome do cliente solicitante e do serviço solicitado em /var/log/secure ou /var/log/messages.

libwrap.a. Algumas dessas aplicações incluem /usr/sbin/sshd, /usr/sbin/sendmail, and /usr/sbin/xinetd.

Nota

libwrap.a, digite o seguinte comando como usuário root:

ldd <binary-name> | grep libwrap

libwrap.a.

/usr/sbin/sshd está ligado ao libwrap.a:

[root@myServer ~]# ldd /usr/sbin/sshd | grep libwrap

libwrap.so.0 => /lib/libwrap.so.0 (0x00655000)

[root@myServer ~]#2.3.1.1. Vantagens do TCP Wrappers

- Transparências tanto aos clientes e serviços de rede wrapped — Ambos clientes em conexão e o serviço de rede wrapped não estão atentos que os TCP Wrappers estão em uso. Usuários legítimos são autenticados e conectados ao serviço solicitado enquanto conexões de clientes banidos falham.

- Gerenciamento Centralizado de múltiplos protocolos — Os TCP Wrappers operam separadamente dos serviços de rede que protegem, permitindo muitas aplicações de servidor compartilhar um conjunto comum de arquivos de configurações de controle de acesso, para um gerenciamento mais simples.

2.3.2. Arquivos de Configuração dos TCP Wrappers

/etc/hosts.allow/etc/hosts.deny

- Ele faz referencia ao

/etc/hosts.allow— O serviço TCP wrapper analisa sequencialmente o arquivo/etc/hosts.allowe aplica a primeira regra especificada para aquele serviço. Se ele encontra uma regra correspondente, ele permite a conexão. Se não, vai para o próximo passo. - Ele faz referência ao

/etc/hosts.deny— O serviço TCP wrapper analisa sequencialmente o arquivo/etc/hosts.deny. Se ele encontrar uma regra correspondente, ele nega a conexão. Se não, garante acesso ao serviço.

- Como as regras de acesso no

hosts.allowsão aplicadas primeiro, elas têm preferência sobre as regras especificadas nohosts.deny. Portanto, se o acesso a um serviço é permitido nohosts.allow, uma regra negando acesso ao mesmo serviçohosts.denyé ignorado. - As regras em cada arquivo são lidas de cima para baixo e a primeira regra correspondente para um determinado serviço é a única aplicada. A ordem das regras é extremamente importante.

- Se nenhuma regra para o serviço é encontrada em qualquer arquivo ou nenhum arquivo existe, acesso ao serviço é garantido.

- Os serviços TCP wrappers não fazem cache das regras dos arquivos de acesso dos hosts, então quaisquer mudanças no

hosts.allowouhosts.denyacontecem imediatamente, sem reiniciar os serviços de rede.

Atenção

/var/log/messages ou /var/log/secure. Isto é também o caso para uma regra que se extende por múltiplas linhas sem usar a barra invertida. O seguinte exemplo ilustra a porção relevante de uma mensagem de log para uma falha de regra devido a uma dessas circunstâncias:

warning: /etc/hosts.allow, line 20: missing newline or line too long

2.3.2.1. Formatando Regras de Acesso

/etc/hosts.allow e /etc/hosts.deny são idênticos. Cada regra deve estar em sua própria linha. Linhas em branco ou linhas que iniciam com um hash (#) são ignoradas.

<daemon list>: <client list> [: <option>: <option>: ...]

- <daemon list> — Uma lista separada por vírgula de nomes de processos (não os nomes dos serviços) ou o carácter coringa

ALL. A lista daemon também aceita operadores (consulte a Seção 2.3.2.1.4, “Operadores”) para permitir maior flexibilidade. - <client list> — Uma lista separada por vígula de nomes de host, endereços IP de host, modelos especiais ou carácteres coringa que identificam os hosts afetados pela regra. A lista de clientes também aceita operadores listados na Seção 2.3.2.1.4, “Operadores” para permitir maior flexibilidade.

- <option> — Uma ação opcional ou lista separada por dois pontos de ações realizadas quando a regra é acionada. Campos opcionais suportam expansões, dão inicio à comandos shell, permitem ou negam acesso e alteram o comportamento de logging.

Nota

vsftpd : .example.com

vsftpd) de qualquer host no domínio example.com. Se esta regra aparecer no hosts.allow, a conexão é aceita. Se esta regra aparecer no hosts.deny, a conexão é rejeitada.

sshd : .example.com \ : spawn /bin/echo `/bin/date` access denied>>/var/log/sshd.log \ : deny

sshd) é tentada a partir de um host no domínio example.com, executa o comando echo para anexar a tentativa ao arquivo de log especial e nega a conexão. Pelo motivo que a diretiva opcional deny é usada, esta linha nega o acesso mesmo se ele aparecer no arquivo hosts.allow. Consulte a Seção 2.3.2.2, “Campos de Opção” para uma visão mais detalhada das opções disponíveis.

2.3.2.1.1. Carácteres Coringa (wildcards)

ALL— Corresponde a tudo. Ele pode ser usado para ambas listas de daemons e lista de clientes.LOCAL— Corresponde a qualquer host que não contém um ponto (.), como o localhost.KNOWN— Corresponde a qualquer host onde o hostname e endereço de host são conhecidos ou onde o usuário é conhecido.UNKNOWN— Corresponde a qualquer host onde o hostname ou endereço de host são desconhecidos ou onde o usuário é desconhecido.PARANOID— Corresponde a qualquer host onde o hostname não corresponde ao endereço de host.

Importante

KNOWN, UNKNOWN e PARANOID devem ser usados com cuidado, por causa que eles dependem em um servidor DNS em funcionamento para que a operação seja correta. Qualquer disruptura na resolução de nome pode impedir usuários legítimos de ganhar acesso ao serviço.

2.3.2.1.2. Modelos

- Hostname iniciando com ponto (.) — Colocar um ponto no início de um hostname corresponde a todos os hosts compartilhando os componentes listados do nome. O exemplo a seguir se aplica a qualquer host dentro do domínio

example.com:ALL : .example.com

- Endereço de IP terminando com um ponto (.) — Colocar um ponto no final do endereço IP corresponde a todos os hosts compartilhando os grupos numéricos iniciais de um endereço de IP. O exemplo seguinte se aplica a qualquer host dentro da rede

192.168.x.x:ALL : 192.168.

- endereço de IP /par máscara de rede — Expressões de máscara de rede podem também ser usadas como um modelo para controlar acesso a um grupo particular de endereços IP. O exemplo seguinte se aplica a qualquer host com uma variação de endereço de

192.168.0.0até192.168.1.255:ALL : 192.168.0.0/255.255.254.0

Importante

Quando trabalhar com espaço de endereço IPv4, a extensão do endereço/prefixo (prefixlen) declarações de par (notação CIDR) não são suportadas. Somente regras IPv6 podem usar este formato. - [endereço IPv6]/par prefixlen — pares [net]/prefixlen podem também ser usados como um modelo para controlar acesso a um grupo particular de endereços IPv6. O exemplo seguinte se aplicaria a qualquer host com uma faixa de

3ffe:505:2:1::até3ffe:505:2:1:ffff:ffff:ffff:ffff:ALL : [3ffe:505:2:1::]/64

- O asterisco (*) — Asteriscos podem ser usados para corresponder grupos inteiros de hostnames ou endereços de IP, desde que eles não sejam misturados em uma lista de clientes contendo outros tipos de modelos. O exemplo seguinte se aplicaria a qualquer host dentro do domínio

example.com:ALL : *.example.com

- A barra (/) — Se uma lista de clientes iniciar com uma barra (/), ela é tratada como um nome de arquivo. Isto é útil se regras especificando números grandes de hosts são necessárias. O exemplo seguinte se refere aos TCP Wrappers para o arquivo

/etc/telnet.hostspara todas as conexões Telnet:in.telnetd : /etc/telnet.hosts

hosts_access para mais informações.

Atenção

2.3.2.1.3. Portmap e TCP Wrappers

Portmap de TCP Wrappers não suporta busca de hosts, que siginifca que o portmap não pode usar hostnames para identificar hosts. Consequentemente, regras de controle de acesso para portmap no hosts.allow ou hosts.deny devem usar endereços de IP ou a palavra chave ALL, para especificar os hosts.

portmap podem não ter efeito imediatamente. Você pode necessitar reiniciar o serviço portmap.

portmap para operar, então esteja atento à estas limitações.

2.3.2.1.4. Operadores

EXCEPT. Ele pode ser usado em ambas listas daemon e listas clientes para uma regra.

EXCEPT permite exceções específicas para abranger correspondências com a mesma regra.

hosts.allow, todos os hosts example.com são permitidos se conectarem a todos os serviços, exceto cracker.example.com:

ALL: .example.com EXCEPT cracker.example.com

hosts.allow, clientes da rede 192.168.0.x podem usar todos os serviços exceto para o FTP:

ALL EXCEPT vsftpd: 192.168.0.

Nota

EXCEPT. Isto permite a outros administradores rapidamente escanear os arquivos apropriados para ver quais hosts tem acesso permitido ou negado aos serviços sem ter de classificar operadores EXCEPT.

2.3.2.2. Campos de Opção

2.3.2.2.1. Registro de Logs

severity.

example.com são registradas à facilidade authpriv syslog (por causa que nenhum valor de facilidade é especificado) com uma prioridade de emerg:

sshd : .example.com : severity emerg

severity. O seguinte exemplo registra em log qualquer tentativa de conexão SSH por hosts do domínio example.com à facilidade local0 com a prioridade de alert:

sshd : .example.com : severity local0.alert

Nota

syslogd) esteja configurado para registrar no log a facilidade local0. Consulte a página man syslog.conf para informações sobre configurar facilidades de log personalizadas.

2.3.2.2.2. Controle de Acesso

allow ou deny como a opção final.

client-1.example.com, mas negam conexões do client-2.example.com:

sshd : client-1.example.com : allow sshd : client-2.example.com : deny

hosts.allow ou hosts.deny. Alguns administratores consideram isso uma maneira fácil de organizar regras de acesso.

2.3.2.2.3. Comandos Shell

spawn— Realiza um comando shell como um processo filho. Esta diretiva pode realizar tarefas como usar o/usr/sbin/safe_fingerpara obter mais informações sobre o cliente solicitante ou criar arquivos especiais de log usando o comandoecho.No exemplo seguinte, clientes que tentam acessar os serviços Telnet a partir do domínioexample.comsão silenciosamente registrados ao log de um arquivo especial:in.telnetd : .example.com \ : spawn /bin/echo `/bin/date` from %h>>/var/log/telnet.log \ : allow

twist— Substitui o serviço solicitado com o comando especificado. Esta diretiva é frequentemente usada para configurar armadilhas para invasores (também chamados "honey pots" (potes de mel). Ele também pode ser usado para enviar mensagens para clientes em conexão. A diretivatwistdeve ocorrer no final da linha da regra.No exemplo seguinte, clientes que tentam acessar os serviços FTP do domínioexample.comrecebem uma mensagem usando o comandoecho:vsftpd : .example.com \ : twist /bin/echo "421 This domain has been black-listed. Access denied!"

hosts_options.

2.3.2.2.4. Expansões

spawn e twist, fornecem informações sobre o cliente, servidor e processos envolvidos.

%a— Retorna o endereço IP do cliente.%A— Retorna o endereço IP do servidor.%c— Retorna uma variedade de informações dos clientes, como o nome de usuário e hostname ou o nome de usuário e endereço IP.%d— Retorna o nome do processo daemon.%h— Retorna o hostname do cliente (ou endereço IP, se o hostname estiver indisponível).%H— Retorna o hostname do servidor (ou endereço IP, se o hostname estiver indisponível).%n— Retorna o hostname do cliente. Se indisponível,unknowné mostrado. Se o hostname do cliente e endereço de host não correpondem,paranoidé mostrado.%N— Retorna o hostname do servidor. Se indisponível,unknowné mostrado. Se o hostname do servidor e endereço de host não correspondem,paranoidé mostrado.%p— Retorna o ID do processo daemon.%s— Retorna vários tipos de informações do servidor, como processo daemon e o host ou endereço IP do servidor.%u— Retorna o nome de usuário. Se indisponível,unknowné mostrado.

spawn para identificar o host do cliente em um arquivo de log personalizado.

sshd) são tentadas de um host no domínio example.com , execute o comando echo para registrar as tentativas, incluindo o hostname do cliente (usando a expansão %h), a um arquivo especial:

sshd : .example.com \ : spawn /bin/echo `/bin/date` access denied to %h>>/var/log/sshd.log \ : deny

example.com são informados que eles foram banidos do servidor:

vsftpd : .example.com \ : twist /bin/echo "421 %h has been banned from this server!"

hosts_access (man 5 hosts_access) e a página man para hosts_options.

2.3.3. xinetd

xinetd é um super serviço do TCP Wrapper que controla acesso de um sub conjuntos de serviços de redes populares, incluindo FTP, IMAP e Telnet. Ele também fornece opções de configuração especificas de serviço para controle de acesso, registro de log melhorados, vinculação, redirecionamento, e controle de utilização de recursos.

xinetd, o super serviço recebe o pedido e verifica por quaisquer regras de controle de acesso dos TCP Wrappers.

xinetd verifica que a conexão é permitida sobre suas próprias regras de acesso para esse serviço. Ele também verifica que o serviço é capaz de ter mais recursos atribuídos a ele e não quebra nenhuma das regras definidas.

xinetd então inicia uma instância do serviço solicitado e passa o controle da conexão à ele. Depois da conexão ter sido estabelecida, o xinetd não faz mais parte da comunicação entre o cliente e o servidor.

2.3.4. Arquivos de Configuração xinetd

xinetd são como a seguir:

/etc/xinetd.conf— O arquivo de configuração global doxinetd./etc/xinetd.d/— O diretório contendo todos os arquivos especificos do serviço.

2.3.4.1. O arquivo /etc/xinetd.conf

/etc/xinetd.conf contém definições de configurações gerais que afetam todos os serviços sob o controle do xinetd. Ele é lido quando o serviço xinetd é primeiramente iniciado, então para as mudanças de configuração terem efeito, você precisa reiniciar o serviço xinetd. O seguinte é um modelo do arquivo /etc/xinetd.conf:

defaults

{

instances = 60

log_type = SYSLOG authpriv

log_on_success = HOST PID

log_on_failure = HOST

cps = 25 30

}

includedir /etc/xinetd.dxinetd:

instances— Especifica o número máximo de pedidos simultâneos que oxinetdpode processar.log_type— Configura oxinetdpara usar a facilidade de logauthpriv, que grava entradas no log para o arquivo/var/log/secure. Adicionar uma diretiva comoFILE /var/log/xinetdlogcriaria um arquivo de log personalizado chamadoxinetdlogno diretório/var/log/.log_on_success— Configura oxinetdpara registrar no log tentativas de conexão com sucesso. Por padrão, o endereço IP do host remoto e o ID de processo do servidor que processo o pedido são gravados,log_on_failure— Configura oxinetdpara logar tentativas de conexão com falhas ou se a conexão foi negada.cps— Configura oxinetdpara permitir não mais que 25 conexões por segundo para qualquer serviço dado. Se este limite é excedido, o serviço é suspenso por 30 segundos.includedir/etc/xinetd.d/— Inclui opções declaradas nos arquivos de configuração de serviço específico localizados no diretório/etc/xinetd.d/. Consulte a Seção 2.3.4.2, “O Diretório /etc/xinetd.d/” para mais informações.

Nota

log_on_success e log_on_failure no /etc/xinetd.conf são também modificadas nos arquivos de configuração de serviços específicos. Mais informações podem entretanto aparecer no arquivo de log do serviço do que o /etc/xinetd.conf pode indicar. Consulte a Seção 2.3.4.3.1, “Opções de Registro de Log” para mais informações.

2.3.4.2. O Diretório /etc/xinetd.d/

/etc/xinetd.d/ contém os arquivos de configuração para cada serviço gerenciado pelo xinetd e os nomes dos arquivos são correlacionados ao serviço. Como ocorre com o xinetd.conf, este diretório é somente leitura quando o serviço é iniciado. Para quaisquer mudanças terem efeito, o administrador deve reiniciar o serviço xinetd.

/etc/xinetd.d/ usam as mesmas convenções como o /etc/xinetd.conf. A razão primária que a configuração para cada serviço é armazenada em um arquivo separado é fazer a personalização mais fácil e menos suscetíveis de afetar outros serviços.

/etc/xinetd.d/krb5-telnet:

service telnet

{

flags = REUSE

socket_type = stream

wait = no

user = root

server = /usr/kerberos/sbin/telnetd

log_on_failure += USERID

disable = yes

}telnet:

service— Especifica o nome do serviço, normalmente um dos listados no arquivo/etc/services.flags— Define um número qualquer de atributos para a conexão. OREUSEinstrui oxinetdpara reusar p socket para a conexão Telnet.Nota

O sinalizadorREUSEestá obsoleto. Todos os serviços agora usam implicitamente o sinalizadorREUSE.socket_type— Define o tipo de socket de rede parastream.wait— Especifica se o serviço é single-threaded (yes) ou multi-threaded (no).user— Especifica qual ID de usuário o processo o rodará.server— Especifica qual binário executável a dar início.log_on_failure— Especifica os parâmetros de registro de log para olog_on_failurealém daqueles já definidos emxinetd.conf.disable— Especifica se o serviço está inativo (yes) ou ativo (no).

xinetd.conf para mais informações sobre estas opções e seu uso.

2.3.4.3. Aterando Arquivos de Configuração xinetd

xinetd. Esta seção destaca algumas das opções mais comumente usadas.

2.3.4.3.1. Opções de Registro de Log

/etc/xinetd.conf e os arquivos específicos de serviço dentro do diretório /etc/xinetd.d/.

ATTEMPT— Registra em log que uma tentativa com falha foi feita (log_on_failure).DURATION— Registra em log o período de tempo que o serviço é usado por um sistema remoto (log_on_success).EXIT— Registra em log o estado de saída ou sinal de término do serviço (log_on_success).HOST— Registra em log o endereço de IP do host remoto (log_on_failureelog_on_success).PID— Registra em log o ID do processo do servidor recebendo o pedido (log_on_success).USERID— Registra em log o usuário remoto usando o método definido em RFC 1413 para todos os serviços de stream multi-threaded (log_on_failureelog_on_success).\n\t\n

xinetd.conf.

2.3.4.3.2. Opções de Controle de Acesso

xinetd podem escolher usar as regras de acesso de hosts TCP Wrappers, fornecer controle de acesso pelos arquivos de configuração xinetd ou uma mistura de ambos. Consulte a Seção 2.3.2, “Arquivos de Configuração dos TCP Wrappers” para mais informações sobre os arquivos de controle de acesso de hosts TCP Wrappers.

xinetd para controlar o acesso aos serviços.

Nota

xinetd reiniciar o serviço xinetd.

xinetd somente afeta serviços controlados pelo xinetd.

xinetd difere do método usado pelos TCP Wrappers. Enquanto os TCP Wrappers colocam toda a configuração de acesso dentro de dois arquivos /etc/hosts.allow e /etc/hosts.deny, o controle de acesso do xinetd é encontrado em cada um dos arquivos de configuração do serviço no diretório /etc/xinetd.d/.

xinetd:

only_from— Permite somente os hosts especificados usarem o serviço.no_access— Bloqueia os hosts listados de usar o serviço.access_times— Especifica o período de tempo quando um determinado serviço pode ser usado. O período de tempo deve ser declarado no formato 24 horas, HH:MM-HH:MM.

only_from e no_access podem usar uma lista de endereços de IP ou nomes de host, ou pode especificar uma rede inteira. Como os TCP Wrappers, combinar o controle de acesso xinetd com a configuração de log avançada pode aumentar a segurança bloqueando pedidos dos hosts banidos enquanto grava a verbosidade de cada tentativa de conexão.

/etc/xinetd.d/telnet pode ser usado para bloquear o acesso Telnet de um grupo de rede particular e restringe o intervalo de tempo de total que mesmo usuários permitidos podem se logar:

service telnet

{

disable = no

flags = REUSE

socket_type = stream

wait = no

user = root

server = /usr/kerberos/sbin/telnetd

log_on_failure += USERID

no_access = 172.16.45.0/24

log_on_success += PID HOST EXIT

access_times = 09:45-16:15

}172.16.45.0/24, como 172.16.45.2, tenta acessar o serviço Telnet, ele recebe a seguinte mensagem:

Conexão fechada por um host externo.

/var/log/messages conforme a seguir:

Sep 7 14:58:33 localhost xinetd[5285]: FAIL: telnet address from=172.16.45.107 Sep 7 14:58:33 localhost xinetd[5283]: START: telnet pid=5285 from=172.16.45.107 Sep 7 14:58:33 localhost xinetd[5283]: EXIT: telnet status=0 pid=5285 duration=0(sec)

xinetd , é importante entender o relacionamento entre os dois mecanismos de controle de acesso.

xinetd quando um cliente solicita uma conexão:

- O daemon

xinetdacessa as regras de acesso de hosts do TCP Wrappers usando uma chamada da bibliotecalibwrap.a. Se uma regra de negação corresponde ao cliente, a conexão é passada para oxinetd. - O daemon

xinetdverifica suas próprias regras de controle de acesso tanto para o serviçoxinetde o serviço solicitado. Se uma regra de negação corresponde ao cliente, a conexão é despejada. Caso contrário , oxinetdinicia uma instância do serviço solicitado e passa o controle da conexão a esse serviço.

Importante

xinetd. Um erro de configuração pode causar efeitos indesejáveis,

2.3.4.3.3. Opções de Associação e Redirecionamento

xinetd suporta a associação do serviço a um endereço de IP e redireciona pedidos de entrada desse serviço para outro endereço IP, hostname ou porta.

bind nos arquivos de configuração de serviço específicos e liga o serviço a um endereço IP no sistema. Quando este é configurado, a opção bind somente permite pedidos ao endereço de IP correto para acessar o serviço. Você pode usar este método para associar diferentes serviços à interfaces de redes diferentes baseadas em requerimentos.

redirect aceita um endereço IP ou hostname seguido por um número de porta. Ela configura o serviço para redirecionar quaisquer pedidos para este serviço ao host e número de porta especificados. Este recurso pode ser usado para apontar para um outro número de porta no mesmo sistema, redirecionar o pedido para um endereço IP diferente na mesma máquina, deslocar o pedido para um sistema e número de porta totalmente diferentes, ou qualquer combinação destas opções. Um usuário conectando a um certo serviço em um sistema pode portanto ser reencaminhado a um outro sistema sem ruptura.

xinetd é capaz de realizar este redirecionamento reproduzindo um processo que permanece vivo pela duração da conexão entre a máquina cliente solicitante e o host que fornece o serviço, transferindo dados entre os dois sistemas.