管理指南

Red Hat Virtualization 中的管理任务

摘要

第 1 章 管理和维护 Red Hat Virtualization

Red Hat Virtualization 环境需要管理员保持它的运行。作为管理员,您的任务包括:

- 管理物理和虚拟资源,如主机和虚拟机.这包括升级和添加主机、导入域、转换外部虚拟机监控程序(hypervisors)上创建的虚拟机,以及管理虚拟机池。

- 监控整体系统资源以了解潜在的问题,如其中一个主机上高负载、内存或磁盘空间不足,以及执行任何必要的操作(例如,将虚拟机迁移到其他主机,以通过关闭机器减少负载或释放资源)。

- 响应对虚拟机的新要求(例如,升级操作系统或分配更多内存)。

- 使用标签管理自定义对象属性。

- 管理保存为公共书签的搜索。

- 管理用户设置和设置权限级别.

- 为特定用户或虚拟机提供整体系统功能的故障排除.

- 生成常规和特定报告.

1.1. 全局配置

通过单击 Administration → Configure,Configure 窗口允许您为 Red Hat Virtualization 环境配置多个全局资源,如用户、角色、系统权限、调度策略、实例类型和 MAC 地址池。此窗口允许您自定义用户与环境中资源交互的方式,并为配置可应用到多个集群的选项提供一个中央位置。

1.1.1. 角色

角色是可从 Red Hat Virtualization Manager 配置的预定义权限集。角色提供对数据中心中不同级别资源以及特定物理和虚拟资源的访问权限和管理权限。

通过多级管理,适用于容器对象的任何权限也适用于该容器中的所有单个对象。例如,当主机管理员角色分配给特定主机上的用户时,该用户将获得执行任何可用主机操作的权限,但只能在分配的主机上获得。但是,如果主机管理员角色分配给数据中心上的用户,该用户将获得在数据中心集群中的所有主机上执行主机操作的权限。

1.1.1.1. 创建新角色

如果您需要的角色不在 Red Hat Virtualization 的默认角色列表中,您可以创建新角色并对其进行自定义以满足您的需要。

流程

- 单击 Administration → Configure。这将打开 Configure 窗口。默认情况下会选择 Roles 选项卡,显示默认用户和管理员角色以及任何自定义角色的列表。

- 单击 New。

- 输入新角色的名称和描述。

- 选择 Admin 或 User 作为帐户类型。

- 使用 Expand All 或 Collapse All 按钮,在 Check Boxes to Allow Action 列表中查看所列对象的一个或多个权限。您还可以扩展或折叠每个对象的选项。

- 对于每个对象,为您要设置的角色选择或清除您想要允许的操作或拒绝的操作。

- 单击确定以应用更改。新角色显示在角色列表中。

1.1.1.2. 编辑或复制角色

您可以更改已创建角色的设置,但无法更改默认角色。要更改默认角色,请克隆并修改它们以符合您的要求。

流程

- 单击 Administration → Configure。这将打开 Configure 窗口,其中显示默认用户和管理员角色以及任何自定义角色的列表。

- 选择您要更改的角色。

- 点 Edit 或 Copy。这将打开 Edit Role 或 Copy Role 窗口。

- 如有必要,编辑角色的 Name 和 Description。

- 使用 Expand All 或 Collapse All 按钮查看列出对象的一个或多个权限。您还可以扩展或折叠每个对象的选项。

- 对于每个对象,选择或清除您希望允许或拒绝您要编辑的角色的操作。

- 单击 OK 以应用您所做的更改。

1.1.1.3. 用户角色和授权示例

以下示例演示了如何使用本章中描述的授权系统的不同功能,针对各种场景应用授权控制。

例 1.1. 集群权限

Sarah 是公司帐户部门的系统管理员。她所在部门的所有虚拟资源都在一个称为 Accounts 的 Red Hat Virtualization 集群。她被分配了 accounts 集群上的 ClusterAdmin 角色。这使她能够管理集群中的所有虚拟机,因为虚拟机是集群的子对象。管理虚拟机包括编辑、添加或删除磁盘等虚拟资源,以及执行快照。这些权限并不允许她管理此集群之外的任何资源。由于 ClusterAdmin 是管理员角色,因此它允许她使用管理门户或虚拟机门户来管理这些资源。

例 1.2. VM PowerUser 权限

John 是财务部门的软件开发人员。他使用虚拟机来构建和测试其软件。Sarah 已为他创建了一个名为 johndesktop 的虚拟桌面。John 被分配了 johndesktop 虚拟机上的 UserVmManager 角色。这允许他使用虚拟机门户访问此单一虚拟机。由于他具有 UserVmManager 权限,因此可以修改虚拟机。由于 UserVmManager 是用户角色,因此不允许他使用管理门户。

例 1.3. 数据中心 Power 用户角色权限

Penelope 是办事处经理。除了她自己的职责外,她偶尔还帮助人力资源经理完成各种任务,如安排访谈和跟进参考检查。根据公司政策,Penelope 需要使用特定的应用程序来完成招聘任务。

虽然 Penelope 拥有自己的机器来执行办公室管理任务,但她希望创建单独的虚拟机来运行该规范应用。为她被分配了新虚拟机的数据中心的 PowerUserRole 权限。这是因为要创建新虚拟机,她需要在数据中心内对多个组件进行更改,包括在存储域中创建虚拟磁盘。

请注意,这与为 Penelope 分配 DataCenterAdmin 权限不同。作为数据中心的 PowerUser,Perenelope 可以登录虚拟机门户,并对数据中心内的虚拟机执行特定于虚拟机的操作。她无法执行数据中心级别的操作,如将主机或存储附加到数据中心。

例 1.4. 网络管理员权限

Chris 担任 IT 部门的网络管理员。她的日常职责包括创建、操作和删除部门 Red Hat Virtualization 环境中的网络。对于她的角色,她需要资源以及每个资源的网络上的管理权限。例如,如果 Chris 对 IT 部门的数据中心具有 NetworkAdmin 权限,她可以在数据中心中添加和删除网络,并为属于数据中心的所有虚拟机附加和分离网络。

例 1.5. 自定义角色权限

Rachel 在 IT 部门工作,负责管理 Red Hat Virtualization 中的用户帐户。她需要添加用户帐户并为它们分配适当的角色和权限的权限。她不会自行使用任何虚拟机,并且不应有权管理主机、虚拟机、集群或数据中心。没有向她提供这一特定权限集的内置角色。必须创建自定义角色,以定义适合 Rachel 位置的权限集合。

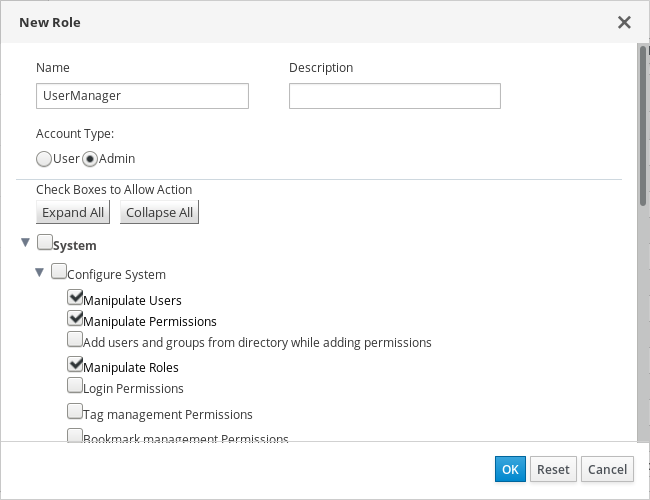

图 1.1. UserManager 自定义角色

上面显示的 UserManager 自定义角色允许操作用户、权限和角色。这些操作在 System - 层次结构中显示的顶层对象下 进行组织。这意味着它们应用到系统的所有其他对象。该角色设置为帐户类型为 Admin。这意味着,当她被分配了此角色时,Rachel 可以同时使用管理门户和虚拟机门户。

1.1.2. 系统权限

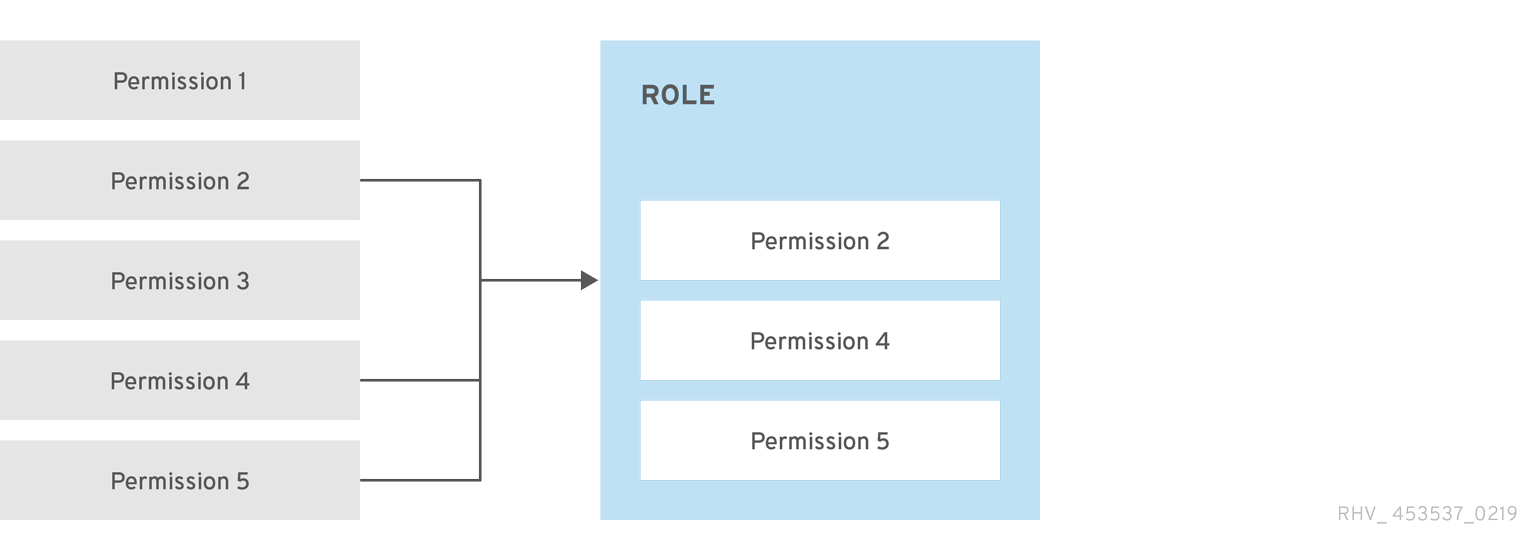

权限允许用户对对象执行操作,其中对象可以是单个对象或容器对象。适用于容器对象的任何权限也适用于该容器的所有成员。

图 1.2. 权限和角色

图 1.3. Red Hat Virtualization 对象层次结构

1.1.2.1. 用户属性

角色和权限是用户的属性。角色是预定义的特权集合,允许访问不同级别的物理和虚拟资源。多级管理提供了精细的权限层次。例如,数据中心管理员具有管理数据中心所有对象的权限,而主机管理员则对单个物理主机具有系统管理员权限。一个用户可以具有使用单一虚拟机的权限,但不会对虚拟机配置进行任何更改,而另一用户则可分配给虚拟机的系统权限。

1.1.2.2. 用户和管理员角色

Red Hat Virtualization 提供一系列预配置的角色,从具有系统范围权限的管理员到有权访问单个虚拟机的最终用户。虽然您无法更改或删除默认角色,但您可以克隆和自定义它们,或者根据您的要求创建新角色。角色有两种类型:

- Administrator 角色:允许使用管理门户来管理物理和虚拟资源。管理员角色限制要在虚拟机门户中执行的操作的权限;但是,它不涉及用户在虚拟机门户中可以看到的内容。

- 用户角色:允许使用虚拟机门户来管理和访问虚拟机和模板。用户角色决定了用户在虚拟机门户中可以看到的内容。授予具有管理员角色的用户的权限反映在虚拟机门户中可供该用户使用的操作中。

1.1.2.3. 用户角色介绍

下表描述了基本用户角色,这些角色授予在虚拟机门户中访问和配置虚拟机的权限。

表 1.1. Red Hat Virtualization 用户角色 - 基础

| 角色 | 权限 | 备注 |

|---|---|---|

| UserRole | 可以访问和使用虚拟机和池. | 可以登录虚拟机门户,使用分配的虚拟机和池,查看虚拟机状态和详细信息。 |

| PowerUserRole | 可以创建和管理虚拟机和模板. | 使用 Configure 窗口,或针对特定数据中心或集群,将这个角色应用到整个环境的用户。例如,如果在数据中心级别上应用 PowerUserRole,PowerUser 可以在数据中心中创建虚拟机和模板。 |

| UserVmManager | 虚拟机的系统管理员. | 可以管理虚拟机并创建和使用快照.在虚拟机门户中创建虚拟机的用户会自动被分配机器上的 UserVmManager 角色。 |

下表描述了高级用户角色,允许您进一步微调虚拟机门户中的资源的权限。

表 1.2. Red Hat Virtualization 用户角色 - 高级

| 角色 | 权限 | 备注 |

|---|---|---|

| UserTemplateBasedVm | 有限的权限,仅能使用模板。 | 可以使用模板创建虚拟机。 |

| DiskOperator | 虚拟磁盘用户。 | 可以使用、查看和编辑虚拟磁盘.继承使用虚拟磁盘所附加虚拟机的权限。 |

| VmCreator | 可以在虚拟机门户中创建虚拟机. | 此角色不适用于特定的虚拟机;使用 Configure 窗口将此角色应用到整个环境的用户。另外,也可以将此角色应用到特定的数据中心或集群。当将此角色应用到集群时,还必须对整个数据中心或特定存储域应用 DiskCreator 角色。 |

| TemplateCreator | 可以在分配的资源内创建、编辑、管理和删除虚拟机模板。 | 此角色不适用于特定的模板;使用 Configure 窗口将此角色应用到整个环境的用户。另外,也可以将这个角色应用到特定的数据中心、集群或存储域。 |

| DiskCreator | 可以在分配的集群或数据中心内创建、编辑、管理和移除虚拟磁盘。 | 此角色不适用于特定的虚拟磁盘;使用 Configure 窗口将此角色应用到整个环境的用户。另外,也可以将这个角色应用到特定的数据中心或存储域。 |

| TemplateOwner | 可以编辑和删除模板,为模板分配和管理用户权限。 | 此角色自动分配给创建模板的用户。其他对模板没有 TemplateOwner 权限的用户无法查看或使用模板。 |

| VnicProfileUser | 虚拟机和模板的逻辑网络和网络接口用户。 | 可以将网络接口从特定逻辑网络附加或分离。 |

1.1.2.4. 管理员角色已说明

下表描述了基本管理员角色,这些角色授予访问管理门户中配置资源的权限。

表 1.3. Red Hat Virtualization 系统管理员角色 - 基础

| 角色 | 权限 | 备注 |

|---|---|---|

| SuperUser | Red Hat Virtualization 环境的系统管理员. | 具有所有对象和级别的完全权限,可以管理所有数据中心中的所有对象。 |

| ClusterAdmin | 集群管理员。 | 拥有特定集群下所有对象的管理权限。 |

| DataCenterAdmin | 数据中心管理员. | 拥有特定数据中心下除存储之外的所有对象的管理权限。 |

不要将目录服务器的管理用户用作 Red Hat Virtualization 管理用户。在目录服务器中创建一个用户,专门用于 Red Hat Virtualization 管理用户。

下表描述了高级管理员角色,允许您对管理门户中的资源的权限进行进一步微调。

表 1.4. Red Hat Virtualization 系统管理员角色 - 高级

| 角色 | 权限 | 备注 |

|---|---|---|

| TemplateAdmin | 虚拟机模板的管理员. | 可以创建、删除和配置模板的存储域和网络详细信息,并在域之间移动模板。 |

| StorageAdmin | 存储管理员。 | 可以创建、删除、配置和管理分配的存储域. |

| HostAdmin | 主机管理员。 | 可以连接、删除、配置和管理特定主机。 |

| NetworkAdmin | 网络管理员。 | 可以配置和管理特定数据中心或集群的网络。数据中心或集群的网络管理员继承集群中虚拟池的网络权限。 |

| VmPoolAdmin | 虚拟池系统管理员。 | 可以创建、删除和配置虚拟池;分配和删除虚拟池用户;可以对池中的虚拟机执行基本操作。 |

| GlusterAdmin | Gluster 存储管理员。 | 可以创建、删除、配置和管理 Gluster 存储卷。 |

| VmImporterExporter | 导入和导出虚拟机的管理员。 | 可以导入和导出虚拟机.能够查看其他用户导出的所有虚拟机和模板。 |

1.1.2.5. 将管理员或用户角色分配给资源

将管理员或用户角色分配到资源,以允许用户访问或管理该资源。

流程

- 查找并单击资源名称。这会打开详情视图。

- 单击 Permissions 选项卡,以列出分配的用户、每个用户的角色以及所选资源的继承权限。

- 点 Add。

- 在搜索文本框中输入现有用户的名称或用户名,然后单击 Go。从生成的可能匹配项列表中选择用户。

- 从 Role to Assign 下拉列表中选择一个角色。

- 点击 OK。

用户现在为该资源启用了该角色的继承权限。

避免将全局权限分配给集群等资源的常规用户,因为权限由系统层次结构中较低资源自动继承。设置 UserRole 以及对特定资源(如虚拟机、池或虚拟机池)的所有其他用户角色权限,特别是后者。

分配全局权限可能会导致两个问题,因为权限继承:

- 普通用户可自动获得控制虚拟机池的权限,即使管理员分配权限并非有意这样做。

- 虚拟机门户可能会与池意外发生。

因此,强烈建议仅对特定资源设置 UserRole 和所有其他用户角色权限,特别是虚拟机池资源,而不设置其他资源从中继承权限的资源。

1.1.2.6. 从资源中删除管理员或用户角色

从资源中删除管理员或用户角色;用户丢失与该资源的角色关联的继承权限。

流程

- 查找并单击资源名称。这会打开详情视图。

- 单击 Permissions 选项卡,以列出分配的用户、用户的角色以及所选资源的继承权限。

- 选择要从资源中删除的用户。

- 单击 Remove。

- 点击 OK。

1.1.2.7. 管理系统权限

作为 SuperUser,系统管理员可以管理管理门户的所有方面。可以为其他用户分配更具体的管理角色。这些受限管理员角色可用于授予用户管理特权,以限制它们仅具有特定资源。例如,DataCenterAdmin 角色仅对分配的数据中心具有管理员特权,但该数据中心的存储除外,ClusterAdmin 则仅对分配的群集具有管理员特权。

数据中心管理员仅仅是特定数据中心的系统管理角色。这在具有多个数据中心(每个数据中心需要管理员)的虚拟化环境中非常有用。DataCenterAdmin 角色是一种分层模型;分配了数据中心管理员角色的用户可以管理数据中心中的所有对象,但该数据中心的存储除外。使用标题栏中的 Configure 按钮,为环境中所有数据中心分配数据中心管理员。

数据中心管理员角色允许执行以下操作:

- 创建和删除与数据中心关联的集群。

- 添加和删除与数据中心关联的主机、虚拟机和池。

- 编辑与数据中心关联的虚拟机的用户权限。

您只能将角色和权限分配给现有用户。

您可以通过删除现有系统管理员并添加新系统管理员来更改数据中心的系统管理员。

1.1.2.8. 数据中心管理员角色说明

数据中心权限角色

下表描述了适用于数据中心管理的管理员角色和特权。

表 1.5. Red Hat Virtualization 系统管理员角色

| 角色 | 权限 | 备注 |

|---|---|---|

| DataCenterAdmin | 数据中心管理员 | 可以使用、创建、删除、管理特定数据中心内的所有物理和虚拟资源,但存储除外,包括集群、主机、模板和虚拟机。 |

| NetworkAdmin | 网络管理员 | 可以配置和管理特定数据中心的网络。数据中心的网络管理员还继承数据中心内虚拟机的网络权限。 |

1.1.2.9. 管理系统权限

作为 SuperUser,系统管理员可以管理管理门户的所有方面。可以为其他用户分配更具体的管理角色。这些受限管理员角色可用于授予用户管理特权,以限制它们仅具有特定资源。例如,DataCenterAdmin 角色仅对分配的数据中心具有管理员特权,但该数据中心的存储除外,ClusterAdmin 则仅对分配的群集具有管理员特权。

集群管理员仅是特定集群的系统管理角色。这在具有多个集群的数据中心中很有用,每个集群都需要系统管理员。ClusterAdmin 角色是一种层次结构模型:被分配了集群管理员角色的用户可以管理群集中的所有对象。使用标题栏中的 Configure 按钮,为环境中所有群集分配集群管理员。

集群管理员角色允许执行以下操作:

- 创建和删除关联的集群。

- 添加和删除与集群关联的主机、虚拟机和池。

- 编辑与集群关联的虚拟机的用户权限。

您只能将角色和权限分配给现有用户。

您还可以删除现有系统管理员并添加新系统管理员来更改集群的系统管理员。

1.1.2.10. 集群管理员角色已说明

集群权限角色

下表描述了适用于集群管理的管理角色和特权。

表 1.6. Red Hat Virtualization 系统管理员角色

| 角色 | 权限 | 备注 |

|---|---|---|

| ClusterAdmin | Cluster Administrator | 可以使用、创建、删除、管理特定集群中的所有物理和虚拟资源,包括主机、模板和虚拟机。可以在集群中配置网络属性,如指定显示网络,或者将网络标记为必需或非必需网络。 但是,ClusterAdmin 没有从集群附加或分离网络的权限,因此需要 NetworkAdmin 权限。 |

| NetworkAdmin | 网络管理员 | 可以配置和管理特定群集的网络。集群的网络管理员还继承集群中虚拟机的网络权限。 |

1.1.2.11. 管理系统权限

作为 SuperUser,系统管理员可以管理管理门户的所有方面。可以为其他用户分配更具体的管理角色。这些受限管理员角色可用于授予用户管理特权,以限制它们仅具有特定资源。例如,DataCenterAdmin 角色仅对分配的数据中心具有管理员特权,但该数据中心的存储除外,ClusterAdmin 则仅对分配的群集具有管理员特权。

网络管理员是一种系统管理角色,可应用于特定网络,或数据中心、群集、主机、虚拟机或模板上的所有网络。网络用户可以执行有限的管理角色,如在特定虚拟机或模板上查看和附加网络。您可以使用标题栏中的 Configure 按钮为环境中的所有网络分配网络管理员。

网络管理员角色允许执行以下操作:

- 创建、编辑和删除网络。

- 编辑网络的配置,包括配置端口镜像。

- 在资源(包括集群和虚拟机)上附加和分离网络。

系统会自动为创建网络的用户分配所创建网络上的 NetworkAdmin 权限。您还可以删除现有管理员并添加新管理员来更改网络的管理员。

1.1.2.12. 网络管理员和用户角色说明

网络权限角色

下表描述了适用于网络管理的管理员、用户角色和特权。

表 1.7. Red Hat Virtualization 网络管理员和用户角色

| 角色 | 权限 | 备注 |

|---|---|---|

| NetworkAdmin | 数据中心、集群、主机、虚拟机或模板的网络管理员.系统会自动为创建网络的用户分配所创建网络上的 NetworkAdmin 权限。 | 可以配置和管理特定数据中心、集群、主机、虚拟机或模板的网络。数据中心或集群的网络管理员继承集群中虚拟池的网络权限。要在虚拟机网络上配置端口镜像,请在网络上应用 NetworkAdmin 角色,并在虚拟机上应用 UserVmManager 角色。 |

| VnicProfileUser | 虚拟机和模板的逻辑网络和网络接口用户。 | 可以将网络接口从特定逻辑网络附加或分离。 |

1.1.2.13. 管理系统权限

作为 SuperUser,系统管理员可以管理管理门户的所有方面。可以为其他用户分配更具体的管理角色。这些受限管理员角色可用于授予用户管理特权,以限制它们仅具有特定资源。例如,DataCenterAdmin 角色仅对分配的数据中心具有管理员特权,但该数据中心的存储除外,ClusterAdmin 则仅对分配的群集具有管理员特权。

主机管理员仅仅是特定主机的系统管理角色。这在有多个主机的集群中很有用,每个主机都需要系统管理员。您可以使用标题栏中的 Configure 按钮为环境中所有主机分配主机管理员。

主机管理员角色允许执行以下操作:

- 编辑主机的配置。

- 设置逻辑网络。

- 删除主机。

您还可以删除现有系统管理员并添加新系统管理员来更改主机的系统管理员。

1.1.2.14. 主机管理员角色已说明

主机权限角色

下表描述了适用于主机管理的管理角色和特权。

表 1.8. Red Hat Virtualization 系统管理员角色

| 角色 | 权限 | 备注 |

|---|---|---|

| HostAdmin | 主机管理员 | 可以配置、管理和删除特定主机。还可以在特定主机上执行网络相关的操作。 |

1.1.2.15. 为存储域管理系统权限

作为 SuperUser,系统管理员可以管理管理门户的所有方面。可以为其他用户分配更具体的管理角色。这些受限管理员角色可用于授予用户管理特权,以限制它们仅具有特定资源。例如,DataCenterAdmin 角色仅对分配的数据中心具有管理员特权,但该数据中心的存储除外,ClusterAdmin 则仅对分配的群集具有管理员特权。

存储管理员只是特定存储域的系统管理角色。这在具有多个存储域的数据中心中很有用,每个存储域都需要系统管理员。使用标题栏中的 Configure 按钮,为环境中所有存储域分配存储管理员。

存储域管理员角色允许执行以下操作:

- 编辑存储域的配置。

- 将存储域移至维护模式。

- 删除存储域。

您只能将角色和权限分配给现有用户。

您还可以删除现有系统管理员并添加新系统管理员来更改存储域的系统管理员。

1.1.2.16. 存储管理员角色已说明

存储域权限角色

下表描述了适用于存储域管理的管理角色和特权。

表 1.9. Red Hat Virtualization 系统管理员角色

| 角色 | 权限 | 备注 |

|---|---|---|

| StorageAdmin | 存储管理员 | 可以创建、删除、配置和管理特定的存储域. |

| GlusterAdmin | Gluster 存储管理员 | 可以创建、删除、配置和管理 Gluster 存储卷。 |

1.1.2.17. 为虚拟机池管理系统权限

作为 SuperUser,系统管理员可以管理管理门户的所有方面。可以为其他用户分配更具体的管理角色。这些受限管理员角色可用于授予用户管理特权,以限制它们仅具有特定资源。例如,DataCenterAdmin 角色仅对分配的数据中心具有管理员特权,但该数据中心的存储除外,ClusterAdmin 则仅对分配的群集具有管理员特权。

虚拟机池管理员是数据中心中虚拟机池的系统管理角色。此角色可以应用到特定的虚拟机池、数据中心或整个虚拟化环境;这对于允许不同的用户管理某些虚拟机池资源非常有用。

虚拟机池管理员角色允许执行以下操作:

- 创建、编辑和删除池。

- 将虚拟机从池中添加和分离。

您只能将角色和权限分配给现有用户。

1.1.2.18. 虚拟机池管理员角色说明

池权限角色

下表描述了适用于池管理的管理角色和特权。

表 1.10. Red Hat Virtualization 系统管理员角色

| 角色 | 权限 | 备注 |

|---|---|---|

| VmPoolAdmin | 虚拟池的系统管理员角色. | 可以创建、删除和配置虚拟池,分配和删除虚拟池用户,以及对虚拟机执行基本操作。 |

| ClusterAdmin | Cluster Administrator | 可以使用、创建、删除、管理特定集群中的所有虚拟机池. |

1.1.2.19. 为虚拟磁盘管理系统权限

作为 SuperUser,系统管理员可以管理管理门户的所有方面。可以为其他用户分配更具体的管理角色。这些受限管理员角色可用于授予用户管理特权,以限制它们仅具有特定资源。例如,DataCenterAdmin 角色仅对分配的数据中心具有管理员特权,但该数据中心的存储除外,ClusterAdmin 则仅对分配的群集具有管理员特权。

Red Hat Virtualization Manager 提供两个默认虚拟磁盘用户角色,但没有默认的虚拟磁盘管理员角色。其中一个用户角色 DiskCreator 角色允许从虚拟机门户管理虚拟磁盘。此角色可应用于特定的虚拟机、数据中心、特定存储域或整个虚拟化环境;这对于允许不同的用户管理不同的虚拟资源非常有用。

虚拟磁盘创建者角色允许执行以下操作:

- 创建、编辑和删除与虚拟机或其他资源关联的虚拟磁盘。

- 编辑虚拟磁盘的用户权限。

您只能将角色和权限分配给现有用户。

1.1.2.20. 虚拟磁盘用户角色已说明

虚拟磁盘用户权限角色

下表描述了适用于在虚拟机门户中使用和管理虚拟磁盘的用户角色和特权。

表 1.11. Red Hat Virtualization 系统管理员角色

| 角色 | 权限 | 备注 |

|---|---|---|

| DiskOperator | 虚拟磁盘用户。 | 可以使用、查看和编辑虚拟磁盘.继承使用虚拟磁盘所附加虚拟机的权限。 |

| DiskCreator | 可以在分配的集群或数据中心内创建、编辑、管理和移除虚拟磁盘。 | 此角色不适用于特定的虚拟磁盘;使用 Configure 窗口将此角色应用到整个环境的用户。另外,也可以将这个角色应用到特定的数据中心、集群或存储域。 |

1.1.2.20.1. 设置传统 SPICE 密码

SPICE 控制台默认使用 FIPS 兼容加密和密码字符串。默认的 SPICE 密码字符串为: kECDHE+FIPS:kDHE+FIPS:kRSA+FIPS:!eNULL:!aNULL:!aNULL

此字符串通常已足够。但是,如果您的虚拟机具有较旧的操作系统或 SPICE 客户端,其中一个或另一个不支持 FIPS 兼容的加密,则必须使用更弱的密码字符串。否则,如果您在现有集群中安装新集群或新主机并尝试连接到该虚拟机,则可能会出现连接安全错误。

您可以使用 Ansible playbook 更改密码字符串。

更改密码字符串

在 Manager 计算机上,在

/usr/share/ovirt-engine/playbooks目录中创建文件。例如:# vim /usr/share/ovirt-engine/playbooks/change-spice-cipher.yml

在文件中输入以下内容并保存它:

name: oVirt - setup weaker SPICE encryption for old clients hosts: hostname vars: host_deploy_spice_cipher_string: 'DEFAULT:-RC4:-3DES:-DES' roles: - ovirt-host-deploy-spice-encryption运行您刚才创建的文件:

# ansible-playbook -l hostname /usr/share/ovirt-engine/playbooks/change-spice-cipher.yml

或者,您可以使用带有变量 host_deploy_spice_cipher_string 的 --extra-vars 选项的 Ansible playbook ovirt-host-deploy 重新配置主机:

# ansible-playbook -l hostname \

--extra-vars host_deploy_spice_cipher_string=”DEFAULT:-RC4:-3DES:-DES” \

/usr/share/ovirt-engine/playbooks/ovirt-host-deploy.yml1.1.3. 调度策略

调度策略是一组规则,用于定义在群集中应用调度策略的主机之间分发虚拟机的逻辑。调度策略通过过滤器、权重和负载平衡策略的组合来确定此逻辑。过滤器模块应用硬实施,并过滤掉不符合该过滤器指定条件的主机。weights 模块应用软实施,用于控制决定集群中可以运行虚拟机的主机时所考虑因素的相对优先级。

Red Hat Virtualization Manager 提供了五种默认的调度策略:Evenly_Distributed, Cluster_Maintenance, None, Power_Saving, 和 VM_Evenly_Distributed。您还可以定义新的调度策略,对虚拟机的分发提供精细的控制。无论调度策略如何,虚拟机都不会在 CPU 过载的主机上启动。默认情况下,如果主机的 CPU 的负载超过 80% 达到 5 分钟,则主机 CPU 被视为过载,但这些值可以使用调度策略来更改。如需有关每个调度策略属性的更多信息,请参阅管理指南中的调度策略。

如需有关调度策略的工作方式的详细信息,请参阅 集群调度策略如何工作?

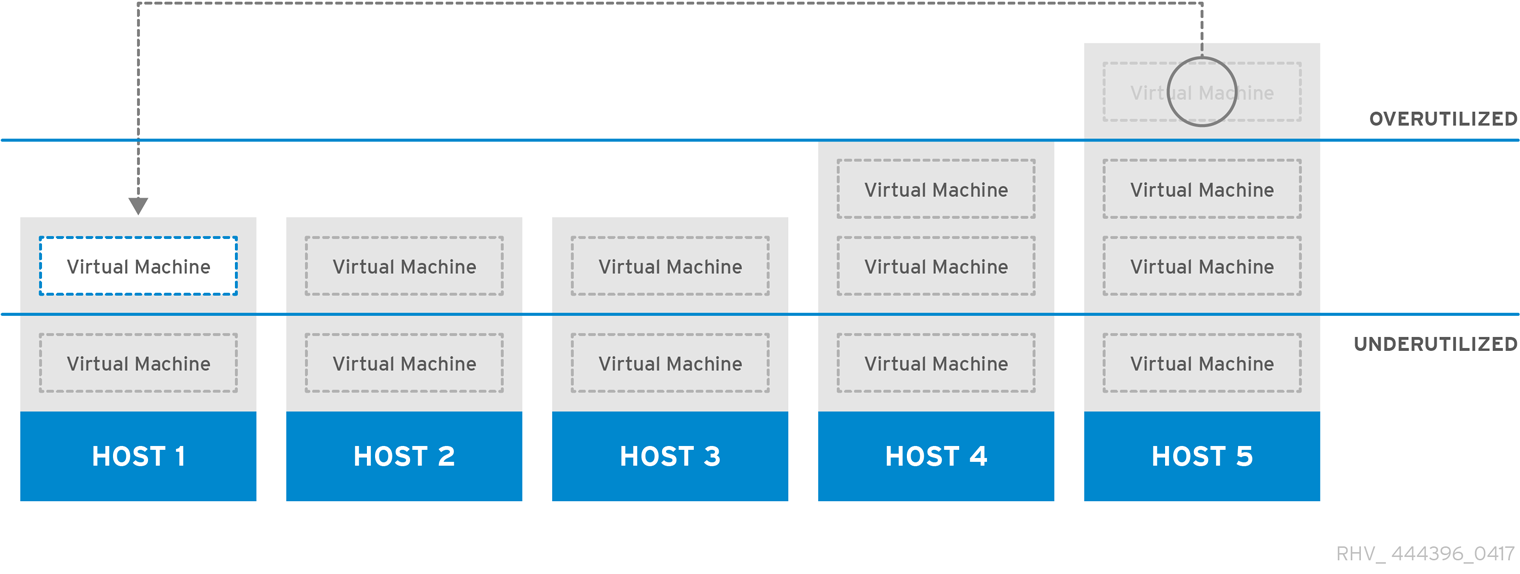

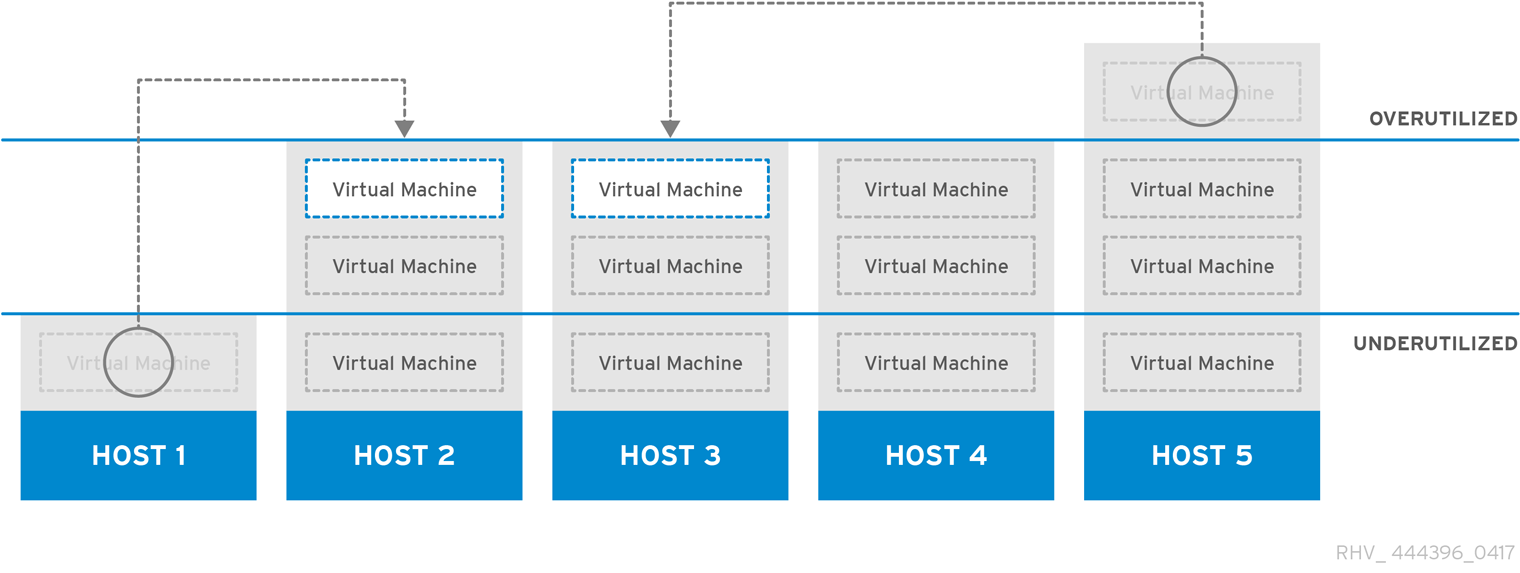

图 1.4. 平均分布式调度策略

Evenly_Distributed 调度策略在集群中的所有主机上平均分配内存和 CPU 处理负载。如果主机已达到定义的 CpuOverCommitDurationMinutes、HighUtilization、VCpuToPhysicalCpuRatio 或 MaxFreeMemoryForOverUtilized,则附加到主机的其他虚拟机将不会启动。

VM_Evenly_Distributed 调度策略根据虚拟机的数量在主机之间均匀分布虚拟机。如果任何主机运行的虚拟机数量超过 HighVmCount,且至少有一个主机具有超出 MigrationThreshold 范围的虚拟机数,则该集群被视为未平衡。

图 1.5. 节能调度策略

Power_Saving 调度策略在可用主机子集之间分配内存和 CPU 处理负载,以减少利用率不足的主机上的功耗。CPU 负载低于低利用率值的主机将超过定义的时间间隔,将所有虚拟机迁移到其他主机,以便将其关闭。如果主机已达到定义的高利用率值,则附加到主机的其他虚拟机将不会启动。

将 None 策略设置为主机之间没有用于运行虚拟机的负载或电源共享。这是默认的模式。当虚拟机启动时,内存和 CPU 处理负载会在集群中的所有主机上均匀分布。如果主机已达到定义的 CpuOverCommitDurationMinutes、HighUtilization 或 MaxFreeMemoryForOverUtilized,则附加到主机的其他虚拟机将不会启动。

Cluster_Maintenance 调度策略在维护任务期间限制集群中的活动。设置 Cluster_Maintenance 策略时,除了高可用性虚拟机外,无法启动新的虚拟机。如果发生主机故障,高可用性虚拟机将正确重新启动,任何虚拟机都可以迁移。

1.1.3.1. 创建调度策略

您可以创建新的调度策略,以控制将虚拟机分布到 Red Hat Virtualization 环境中的给定集群中的逻辑。

流程

- 单击 Administration → Configure。

- 单击调度策略选项卡。

- 单击 New。

- 输入调度策略的 Name 和 Description。

配置过滤器模块:

- 在 Filter Modules 部分中,将要应用到 Disabled Filters 部分中的调度策略的首选过滤器模块拖放到 Enabled Filters 部分中。

- 也可以将特定过滤器模块设置为第一个,被赋予最高优先级 (或 Last ),从而获得最低的优先级,以进行基本的优化。要设置优先级,请右键单击任何过滤器模块,将光标悬停在位置上,然后选择 First 或 Last。

配置权重模块:

- 在 Weights 模块部分中,将应用于 Disabled Weights 部分的首选权重模块拖放到 Enabled Weights & Factors 部分。

- 使用已启用的权重模块左侧的 + 和 - 按钮来增加或减少这些模块的权重。

指定负载平衡策略:

- 从 Load Balancer 部分的下拉菜单中选择要应用到调度策略的负载平衡策略。

- 从 Properties 部分的下拉菜单中,选择要应用到调度策略的负载平衡属性,并使用该属性右侧的文本字段来指定值。

- 使用 + 和 - 按钮来添加或删除其他属性。

- 点击 OK。

1.1.3.2. 新调度策略和编辑调度策略窗口中的设置说明

下表详述了新建调度策略和编辑调度策略窗口中可用的选项。

表 1.12. 新调度策略和编辑调度策略设置

| 字段名称 | Description |

|---|---|

| Name | 调度策略的名称。这是用于引用 Red Hat Virtualization Manager 中的调度策略的名称。 |

| Description | 调度策略的描述信息。建议使用此字段,但不强制设置。 |

| Filter Modules | 用于控制集群中虚拟机可以运行的主机的一组过滤器。启用过滤器将过滤不满足该过滤器指定条件的主机,如下所示:

|

| Weights Modules | 用于控制在决定虚拟机可以运行集群中的主机时所考虑因素的相对优先级的一组权重。

|

| Load Balancer | 此下拉菜单允许您选择要应用的负载平衡模块。负载平衡模块决定了用于将虚拟机从高使用量较高的主机迁移到利用率较低的主机的逻辑。 |

| Properties | 此下拉菜单允许您为负载平衡模块添加或删除属性,并且仅在您为调度策略选择负载平衡模块时才可用。默认情况下不定义任何属性,可用的属性特定于所选的负载平衡模块。使用 + 和 - 按钮向负载平衡模块添加或删除其他属性。 |

1.1.4. 实例类型

实例类型可用于定义虚拟机的硬件配置。创建或编辑虚拟机时选择实例类型将自动填写硬件配置字段。这使得用户可以使用相同硬件配置创建多个虚拟机,而无需手动填写每个字段。

对实例类型的支持现已弃用,并将在以后的发行版本中删除。

下表中所示,默认提供了一组预定义的实例类型:

表 1.13. 预定义的实例类型

| Name | 内存 | VCPU |

|---|---|---|

| tiny | 512 MB | 1 |

| small | 2 GB | 1 |

| Medium | 4 GB | 2 |

| Large | 8 GB | 2 |

| xlarge | 16 GB | 4 |

管理员还可以从 Configure 窗口的 Instance Types 选项卡创建、编辑和删除实例类型。

新虚拟机和编辑虚拟机窗口中绑定到实例类型的字段旁边有一个链链接镜像 (

)。如果更改了其中一个字段的值,则虚拟机将从实例类型分离,更改为 Custom,并且链会出现中断(

)。如果更改了其中一个字段的值,则虚拟机将从实例类型分离,更改为 Custom,并且链会出现中断(

)。但是,如果值被更改回,链将重新链接,实例类型将移回所选类型。

)。但是,如果值被更改回,链将重新链接,实例类型将移回所选类型。

1.1.4.1. 创建实例类型

管理员可以创建新的实例类型,用户可在创建或编辑虚拟机时选择这些类型。

流程

- 单击 Administration → Configure。

- 单击 Instance Types 选项卡。

- 单击 New。

- 输入实例类型的 Name 和 Description。

- 单击 Show Advanced Options,再根据需要配置实例类型的设置。New Instance Type 窗口中出现的设置与 New Virtual Machine 窗口中出现的设置相同,但仅与相关字段相同。请参阅虚拟机管理指南中的新虚拟机和编辑虚拟机 Windows 中的设置说明。

- 点击 OK。

新实例类型将显示在 Configure 窗口中的 Instance Types 选项卡中,可以在创建或编辑虚拟机时从 Instance Type 下拉列表中选择。

1.1.4.2. 编辑实例类型

管理员可以从 Configure 窗口编辑现有的实例类型。

流程

- 单击 Administration → Configure。

- 单击 Instance Types 选项卡。

- 选择要编辑的实例类型。

- 点 Edit。

- 根据需要更改设置。

- 点击 OK。

实例类型的配置已更新。创建基于此实例类型的新虚拟机时,或者更新基于此实例类型的现有虚拟机时,会应用新的配置。

基于此实例类型的现有虚拟机将显示标记为链图标的字段,该字段将更新。如果现有虚拟机在实例类型发生更改时正在运行,则它们旁边将显示 orange Pending Changes 图标,并且在下次重启时将更新链图标的字段。

1.1.4.3. 删除实例类型

流程

- 单击 Administration → Configure。

- 单击 Instance Types 选项卡。

- 选择要删除的实例类型。

- 单击 Remove。

- 如果任何虚拟机都基于要删除的实例类型,则将显示一个警告窗口,列出附加的虚拟机。若要继续删除实例类型,可选中 Approve Operation 复选框。否则,单击取消。

- 点击 OK。

实例类型从 Instance Types 列表中删除,在创建新虚拟机时无法再使用。任何附加到已移除实例类型的虚拟机现在都将附加到自定义 (无实例类型)。

1.1.5. MAC 地址池

MAC 地址池定义为每个集群分配的 MAC 地址范围。为每个集群指定一个 MAC 地址池。通过使用 MAC 地址池,Red Hat Virtualization 可以自动生成 MAC 地址并为新的虚拟网络设备分配,这有助于防止 MAC 地址重复。当与集群相关的所有 MAC 地址都超出所分配的 MAC 地址池的范围时,MAC 地址池的内存池会提高内存效率。

同一 MAC 地址池可由多个集群共享,但每个集群分配了一个 MAC 地址池。Red Hat Virtualization 创建默认 MAC 地址池,并在未分配其他 MAC 地址池时使用。有关为集群分配 MAC 地址池的更多信息,请参阅创建新集群。

如果多个 Red Hat Virtualization 集群共享一个网络,则不要只依赖默认的 MAC 地址池,因为每个集群的虚拟机都将尝试使用相同的 MAC 地址范围,从而导致冲突。为避免 MAC 地址冲突,请检查 MAC 地址池范围,以确保为每个集群分配唯一的 MAC 地址范围。

MAC 地址池分配返回到池的最后一个地址之后的下一个可用 MAC 地址。如果范围中没有剩余地址,则搜索将从范围的开头重新开始。如果有多个 MAC 地址范围中定义了可用 MAC 地址,则范围将以与选择可用 MAC 地址相同的方式为传入的请求提供服务。

1.1.5.1. 创建 MAC 地址池

您可以创建新的 MAC 地址池。

流程

- 单击 Administration → Configure。

- 单击 MAC Address Pools 选项卡。

- 点 Add。

- 输入新 MAC 地址池的名称和描述。

选中 Allow Duplicates 复选框,以允许池中多次使用 MAC 地址。MAC 地址池不会自动使用重复的 MAC 地址,但启用重复选项意味着用户可以手动使用重复的 MAC 地址。

注意如果一个 MAC 地址池被禁用,并且另一个 MAC 地址启用了重复,则池中可以多次使用重复项并禁用重复,但可以在启用了重复功能的池中多次使用。

- 输入所需的 MAC Address Ranges。若要输入多个范围,可单击 From 和 To 字段旁边的加号按钮。

- 点击 OK。

1.1.5.2. 编辑 MAC 地址池

您可以编辑 MAC 地址池来更改详细信息,包括池中可用的 MAC 地址范围以及是否允许重复。

流程

- 单击 Administration → Configure。

- 单击 MAC Address Pools 选项卡。

- 选择要编辑的 MAC 地址池。

- 点 Edit。

根据需要更改 Name, Description, Allow Duplicates, 和 MAC Address Ranges 字段。

注意更新 MAC 地址范围时,不会重新分配现有 NIC 的 MAC 地址。已分配但位于新 MAC 地址范围之外的 MAC 地址作为用户指定的 MAC 地址添加,仍然由 MAC 地址池跟踪。

- 点击 OK。

1.1.5.3. 编辑 MAC 地址池权限

创建 MAC 地址池后,您可以编辑其用户权限。用户权限控制哪些数据中心可以使用 MAC 地址池。有关添加新用户权限的更多信息,请参阅 角色。

流程

- 单击 Administration → Configure。

- 单击 MAC Address Pools 选项卡。

- 选择所需的 MAC 地址池。

编辑 MAC 地址池的用户权限:

在 MAC 地址池中添加用户权限:

- 在 Configure 窗口底部的用户权限窗格中,单击 Add。

- 搜索并选择所需用户。

- 从 Role to Assign 下拉列表中选择所需的角色。

- 单击确定以添加用户权限。

从 MAC 地址池删除用户权限:

- 在 Configure 窗口底部的用户权限窗格中,选择要删除的用户权限。

- 单击 Remove 以删除用户权限。

1.1.5.4. 删除 MAC 地址池

如果池没有与集群关联,您可以删除创建的 MAC 地址池,但无法删除默认的 MAC 地址池。

流程

- 单击 Administration → Configure。

- 单击 MAC Address Pools 选项卡。

- 选择要删除的 MAC 地址池。

- 单击 Remove。

- 点击 OK。

1.2. Dashboard

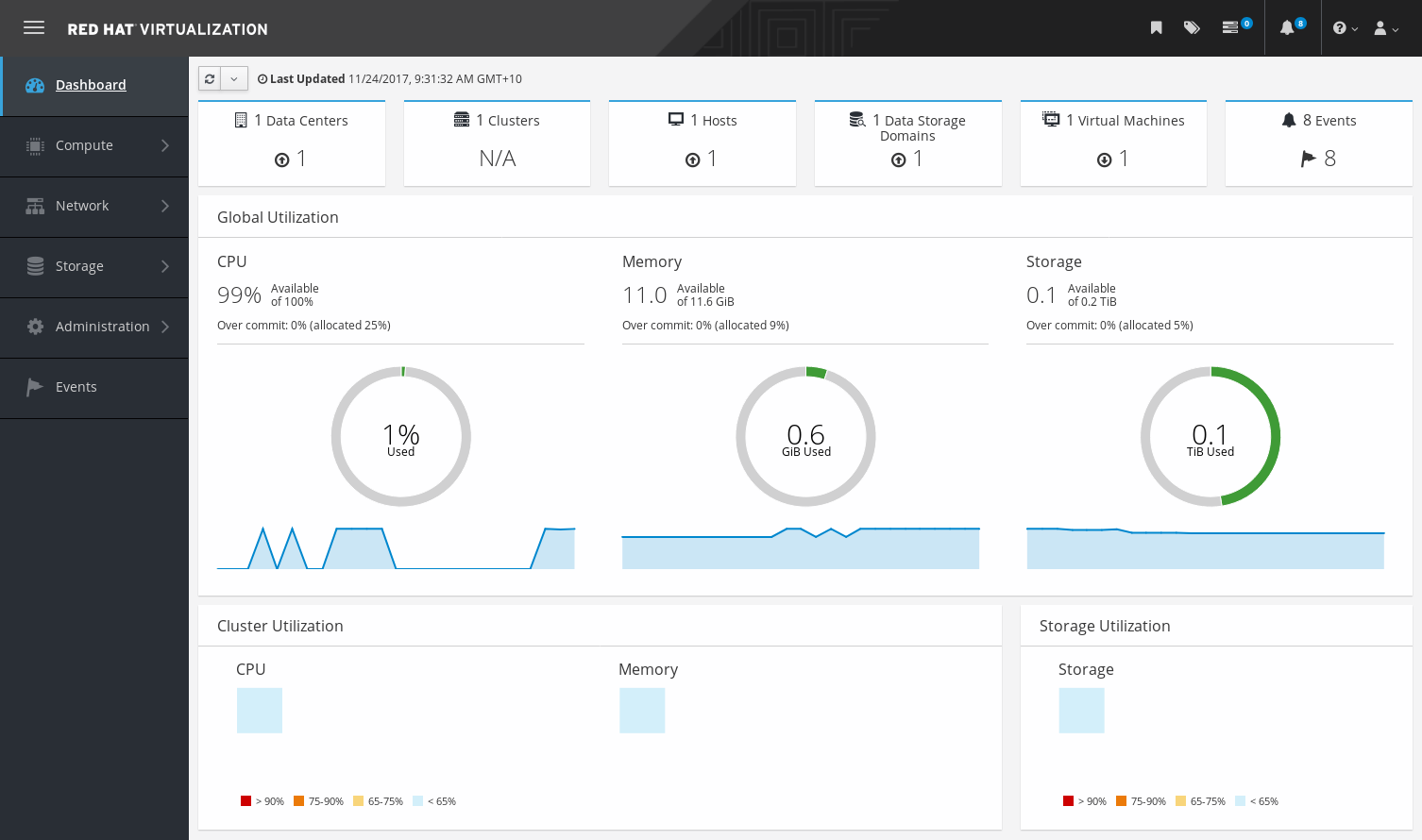

控制面板通过显示 Red Hat Virtualization 资源及利用率的概要来提供 Red Hat Virtualization 系统状态的概述。此概述可能会提醒您问题,并允许您分析问题区域。

默认情况下,仪表板中的信息会从 Data Warehouse 每 15 分钟更新一次,Manager API 默认每 15 秒更新一次,或者每当仪表板被刷新时。当用户从另一个页面更改或手动刷新时,控制面板会被刷新。控制面板不会自动刷新。库存卡信息由 Manager API 提供,利用率信息则由数据仓库提供。控制面板是作为 UI 插件组件实施的,与 Manager 一起自动安装和升级。

图 1.6. 控制面板

1.2.1. 前提条件

控制面板要求安装和配置数据仓库。请参阅数据仓库指南中的安装和配置数据仓库。

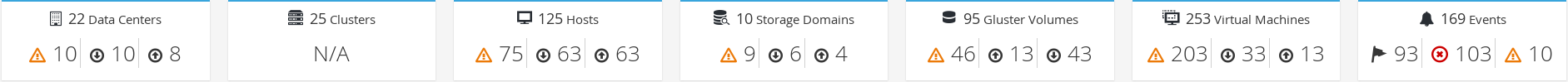

1.2.2. 全局清单

控制面板的顶部部分提供 Red Hat Virtualization 资源的全局清单,包括数据中心、集群、主机、存储域、虚拟机和事件的项。图标显示每个资源的状态,数字则显示具有该状态的每个资源的数量。

图 1.7. 全局清单

标题显示资源类型的数量,其状态显示在标题下方。单击资源标题可导航到 Red Hat Virtualization Manager 中的相关页面。集群的状态始终显示为 N/A。

表 1.14. 资源状态

| 图标 | 状态 |

|---|---|

|

| 这些资源都不添加到 Red Hat Virtualization 中。 |

|

| 显示具有警告状态的资源数。单击图标可导航到相应的页面,搜索范围仅限于该资源,且具有警告状态。每个资源的搜索都会有所不同:

|

|

| 显示具有 up 状态的资源数。单击图标可导航到相应的页面,搜索范围仅限于启动的资源。 |

|

| 显示状态为 down 的资源数量。单击图标可导航到相应的页面,搜索范围仅限于 down 状态的资源。每个资源的搜索都会有所不同:

|

| images:images/Dashboard_Alert.png[title="Alert icon"] | 显示具有警报状态的事件数。单击该图标,导航到 Events,搜索仅限于具有警报严重性的事件。 |

| images:images/Dashboard_Error.png[title="Error icon"] | 显示具有错误状态的事件数。单击该图标可导航到 Events,搜索仅限于具有错误严重性的事件。 |

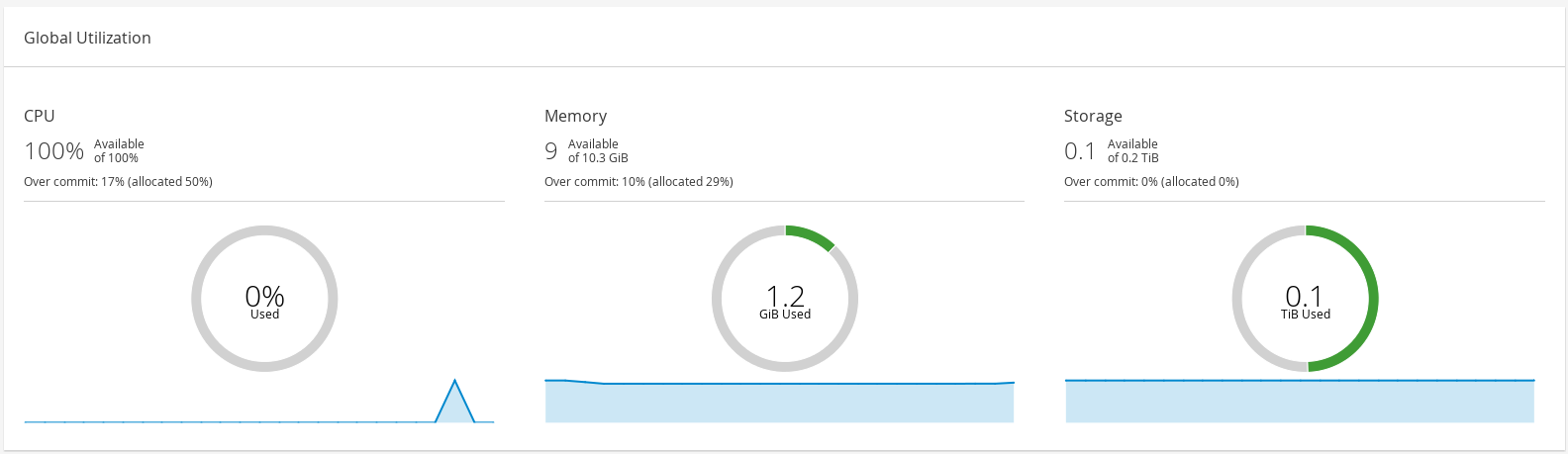

1.2.3. 全局利用率

Global Utilization 部分显示 CPU、内存和存储的系统利用率。

图 1.8. 全局利用率

- top 部分显示可用 CPU、内存或存储的百分比,以及过量提交比率。例如,CPU 的过量提交比率是通过根据数据仓库中最新数据将虚拟内核数除以可用于运行的虚拟机的物理内核数来计算的。

- 圈图以百分比为单位显示 CPU、内存或存储的使用情况,并根据最后 5 分钟的平均使用量显示所有主机的平均使用情况。将鼠标悬停在圆环的某一部分上,将显示所选部分的值。

- 底部的行图在最后 24 小时内显示趋势。每个数据点都显示针对特定小时的平均使用量。将鼠标悬停在图形上的点上可显示 CPU 图形使用的百分比以及内存和存储图的使用情况量。

1.2.3.1. top Utilized Resources

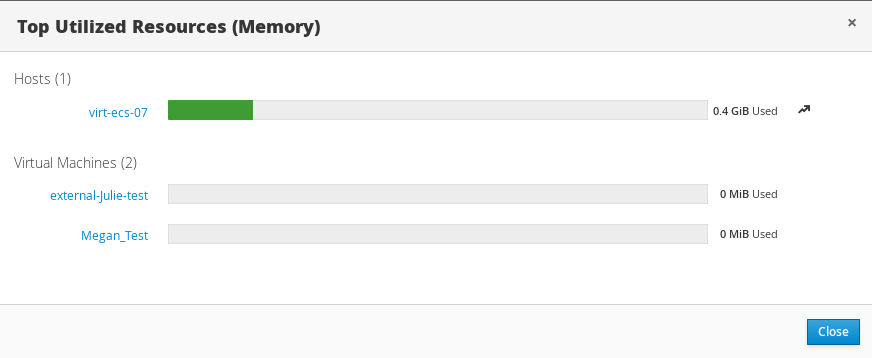

图 1.9. top Utilized Resources (Memory)

点控制面板的全局使用部分中的圆环,将显示 CPU、内存或存储占用最多的资源的列表。对于 CPU 和内存,弹出框显示使用率最高的十个主机和虚拟机列表。对于存储,弹出显示占用的十大存储域和虚拟机的列表。使用栏右侧的箭头显示该资源在最后一分钟内的使用情况。

1.2.4. Cluster Utilization

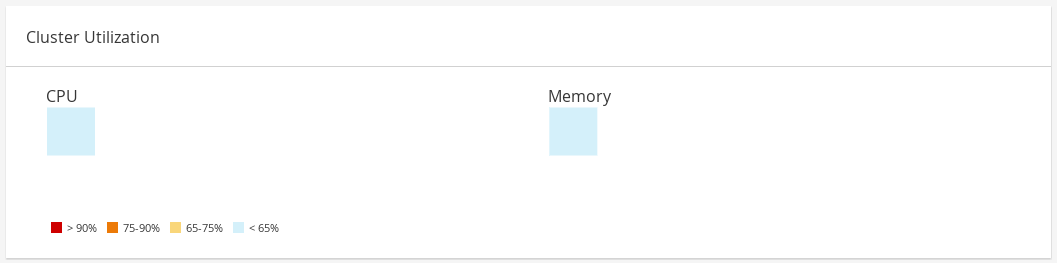

Cluster Utilization 部分显示 heatmap 中 CPU 和内存的集群利用率。

图 1.10. Cluster Utilization

1.2.4.1. CPU

特定集群的 CPU 使用率 heatmap,显示最后 24 小时 CPU 的平均利用率。将鼠标悬停在热图上会显示集群名称。点热图进入 Compute → Hosts,并显示特定集群的搜索结果(按 CPU 使用率排序)。用于计算集群 CPU 的使用情况的公式是集群中平均主机 CPU 利用率。这通过使用上 24 小时内每个主机的平均主机 CPU 利用率计算得出的,以确定集群的 CPU 总数。

1.2.4.2. 内存

特定集群内存使用率的 heatmap,显示最后 24 小时的内存平均利用率。将鼠标悬停在热图上会显示集群名称。点热图进入 Compute → Hosts,并显示特定集群的搜索结果(按内存使用率排序)。用于计算集群内存使用的公式是集群中内存的总使用(以 GB 为单位)。这通过使用上 24 小时内每个主机的平均主机内存利用率计算得出的,以确定集群的内存的总平均使用量。

1.2.5. Storage Utilization

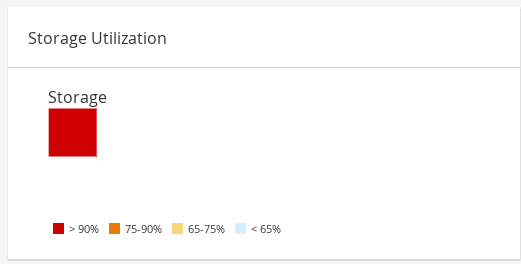

Storage Utilization 部分显示 heatmap 中的存储利用率。

图 1.11. Storage Utilization

热图显示最后 24 小时的存储的平均利用率。用于计算集群存储使用情况的公式是集群中的存储总利用率。这通过使用上 24 小时内每个主机的平均主机存储利用率计算得出的,以确定集群的存储总数。将鼠标悬停在热图上可显示存储域名称。单击 heatmap 将使用按利用率排序的存储域导航到存储 → 域。

1.3. 搜索

1.3.1. 在 Red Hat Virtualization 中执行搜索

管理门户允许您管理数千资源,如虚拟机、主机、用户等。要执行搜索,请在搜索栏中输入搜索查询(自由文本或语法),可在每个资源的主页中找到。搜索查询可以保存为书签以供以后重复使用,因此您不必在每次需要特定搜索结果时重新设置搜索查询。搜索不区分大小写。

1.3.2. 搜索语法和示例

对 Red Hat Virtualization 资源的搜索查询的语法如下:

结果类型:{criteria} [sortby sort_spec]

语法示例

以下示例描述了如何使用搜索查询,并帮助您了解 Red Hat Virtualization 如何协助构建搜索查询。

表 1.15. Search Queries 示例

| Example | 结果 |

|---|---|

| Hosts: Vms.status = up page 2 | 显示正在运行虚拟机的所有主机的列表(第 2 页)。 |

| VM: domain = qa.company.com | 显示在指定域中运行的所有虚拟机的列表。 |

| VM: users.name = Mary | 显示属于用户名称 Mary 的所有虚拟机的列表。 |

| events: severity > normal sortby time | 显示所有严重性高于 Normal 的事件的列表,按时间排序。 |

1.3.3. 搜索 Auto-Completion

管理门户提供自动完成功能,可帮助您创建有效且强大的搜索查询。当您输入搜索查询的每个部分时,搜索的下一部分的下拉列表会在搜索栏下打开。您可以从列表中选择,然后继续键入/选择搜索的下一部分,或者忽略选项并继续手动输入查询。

下表指定,管理门户自动完成有助于构建查询的示例:

Hosts: Vms.status = down

表 1.16. 使用 Auto-Completion 的搜索查询示例

| 输入 | 列出显示的项目 | 操作 |

|---|---|---|

| h |

|

选择 |

| Hosts: | 所有主机属性 | 类型 v |

| Hosts: v |

从 |

选择 |

| Hosts: Vms | 所有虚拟机属性 | 类型 s |

| Hosts:Vms.s |

以 |

选择 |

| Hosts: Vms.status |

| 选择或类型 = |

| Hosts: Vms.status = | 所有状态值 | 选择或类型 关闭 |

1.3.4. 搜索结果类型选项

通过结果类型,您可以搜索任何类型的资源:

- Vms 虚拟机列表

- Host 主机列表

- Pools 池列表

- Template 模块列表

- Events 事件列表

- Users 用户列表

- Cluster 集群列表

- DataCenter 数据中心列表

- Storage 存储域列表

因为每种类型的资源都有一组独特的属性,以及与之关联的一组其他资源类型,因此每个搜索类型都有一组有效的语法组合。您还可以使用自动完成功能轻松创建有效的查询。

1.3.5. 搜索标准

您可以在查询中的冒号后指定搜索条件。{criteria} 的语法如下:

<prop><operator><value>

或者

<obj-type><prop><operator><value>

例子

下表描述了语法的部分:

表 1.17. 搜索条件示例

| Part | Description | 值 | Example | 备注 |

|---|---|---|---|---|

| prop |

search-for 资源的属性。也可以是资源类型的属性(请参阅 | 将搜索范围限制为带有特定属性的对象。例如,搜索具有 status 属性的对象。 | 状态 | N/A |

| obj-type | 与搜索资源关联的资源类型。 | 它们是系统对象,如数据中心和虚拟机。 | 用户 | N/A |

| operator | 比较运算符。 | = != (not equal) > < >= <= | N/A | 值选项取决于属性。 |

| 值 | 哪些表达式与以下内容进行比较: | 字符串 整数 等级 日期(根据区域设置格式化) | jones 256 normal |

|

1.3.6. 搜索:多个标准和通配符

通配符可用于字符串语法的 <value > 部分。例如,要查找以 m 开头的所有用户,请输入 m*。

您可以使用布尔值运算符和 OR 执行具有两个 条件 的搜索。例如:

VM: users.name = m* AND status = Up

此查询返回所有正在运行的虚拟机,适用于其名称以"m"开头的用户。

Vms: users.name = m* AND tag = "paris-loc"

对于名称以"m"开头的用户,此查询会返回带有"paris-loc"标记的所有虚拟机。

在没有使用 AND 或 OR 的情况下指定了两个条件,代表 AND。AND 的优先级高于 OR,OR 的优先级高于没有明确指定的 AND。

1.3.7. 搜索:确定搜索顺序

您可以使用 sortby 确定返回的信息的排序顺序。可以包括排序方向(asc 代表升序,desc 代表降序)。

例如:

events: severity > normal sortby time desc

此查询会返回所有严重性高于 Normal 的事件,按时间排序(降序)。

1.3.8. 搜索数据中心

下表描述了数据中心的所有搜索选项。

表 1.18. 搜索数据中心

| 属性(资源或资源类型) | 类型 | 描述(参考) |

|---|---|---|

|

| 取决于属性类型 | 与数据中心关联的集群属性。 |

|

| 字符串 | 数据中心的名称。 |

|

| 字符串 | 数据中心的描述。 |

|

| 字符串 | 数据中心的类型。 |

|

| list | 数据中心的可用性。 |

|

| list | 根据其中一个资源属性对返回的结果进行排序。 |

|

| 整数 | 要显示的结果的页面数。 |

Example

datacenter: type = nfs and status != up

这个示例返回类型为 NFS 的数据中心列表,以及除 up 以外的状态。

1.3.9. 搜索集群

下表描述了集群的所有搜索选项。

表 1.19. 搜索集群

| 属性(资源或资源类型) | 类型 | 描述(参考) |

|---|---|---|

|

| 取决于属性类型 | 与集群关联的数据中心的属性。 |

|

| 字符串 | 集群所属的数据中心。 |

|

| 字符串 | 标识网络上的集群的唯一名称。 |

|

| 字符串 | 集群的描述。 |

|

| 字符串 | 判断集群的状态的 True 或 False。 |

|

| list | 根据其中一个资源属性对返回的结果进行排序。 |

|

| 整数 | 要显示的结果的页面数。 |

Example

clusters: initialized = true 或 name = Default

本例返回初始化或名为 Default 的集群列表。

1.3.10. 搜索主机

下表描述了主机的所有搜索选项。

表 1.20. 搜索主机

| 属性(资源或资源类型) | 类型 | 描述(参考) |

|---|---|---|

|

| 取决于属性类型 | 与主机关联的虚拟机的属性。 |

|

| 取决于属性类型 | 与主机关联的模板的属性。 |

|

| 取决于属性类型 | 与主机关联的事件的属性。 |

|

| 取决于属性类型 | 与主机关联的用户的属性。 |

|

| 字符串 | 主机的名称。 |

|

| list | 主机的可用性。 |

|

| 字符串 | 外部系统和插件报告的主机的健康状况。 |

|

| 字符串 | 主机所属的集群。 |

|

| 字符串 | 标识网络主机上主机的唯一名称。 |

|

| 整数 | 使用的处理能力百分比。 |

|

| 整数 | 使用的内存百分比。 |

|

| 整数 | 网络使用量的百分比。 |

|

| 整数 | 在给定时间片段中的每个处理器的 run-queue 中执行的作业。 |

|

| 整数 | 操作系统的版本号。 |

|

| 整数 | 主机上的 CPU 数量。 |

|

| 整数 | 可用的内存量。 |

|

| 整数 | CPU 的处理速度。 |

|

| 字符串 | CPU 的类型。 |

|

| 整数 | 当前运行的虚拟机数量。 |

|

| 整数 | 当前迁移的虚拟机数量。 |

|

| 整数 | 已提交的内存百分比。 |

|

| 字符串 | 分配给主机的标签。 |

|

| 字符串 | 主机的类型。 |

|

| 字符串 | 主机所属的数据中心。 |

|

| list | 根据其中一个资源属性对返回的结果进行排序。 |

|

| 整数 | 要显示的结果的页面数。 |

Example

Hosts: cluster = Default 和 Vms.os = rhel6

这个示例返回作为默认集群的一部分的主机列表,以及运行 Red Hat Enterprise Linux 6 操作系统的主机。

1.3.11. 搜索网络

下表描述了网络的所有搜索选项。

表 1.21. 搜索网络

| 属性(资源或资源类型) | 类型 | 描述(参考) |

|---|---|---|

|

| 取决于属性类型 | 与网络关联的集群的属性。 |

|

| 取决于属性类型 | 与网络关联的主机的属性。 |

|

| 字符串 | 标识网络的人类可读名称。 |

|

| 字符串 | 描述网络的关键字或文本(在创建网络时可选使用)。 |

|

| 整数 | 网络的 VLAN ID。 |

|

| 字符串 | 网络是否启用或禁用生成树协议(STP)。 |

|

| 整数 | 逻辑网络的最大传输单元。 |

|

| 字符串 | 网络是否仅用于虚拟机流量。 |

|

| 字符串 | 附加网络的数据中心。 |

|

| list | 根据其中一个资源属性对返回的结果进行排序。 |

|

| 整数 | 要显示的结果的页面数。 |

Example

Network: mtu > 1500 and vmnetwork = true

这个示例会返回一个最大传输单元大于 1500 字节的网络列表,仅用于虚拟机使用。

1.3.12. 搜索存储

下表描述了存储的所有搜索选项。

表 1.22. 搜索存储

| 属性(资源或资源类型) | 类型 | 描述(参考) |

|---|---|---|

|

| 取决于属性类型 | 与存储关联的主机的属性。 |

|

| 取决于属性类型 | 与存储关联的集群的属性。 |

|

| 字符串 | 标识网络上存储的唯一名称。 |

|

| 字符串 | 存储域的状态。 |

|

| 字符串 | 外部系统和插件报告的存储域的健康状况。 |

|

| 字符串 | 存储所属的数据中心。 |

|

| 字符串 | 存储的类型。 |

|

| 整数 | 可用存储的大小(GB)。 |

|

| 整数 | 使用的存储量(GB)。 |

|

| 整数 | 可用存储的总量(GB)。 |

|

| 整数 | 提交的存储量(GB)。 |

|

| list | 根据其中一个资源属性对返回的结果进行排序。 |

|

| 整数 | 要显示的结果的页面数。 |

Example

Storage: free_size > 6 GB 和 total_size < 20 GB

这个示例返回一个存储空间大于 6 GB 的存储列表,或者存储空间总量小于 20 GB。

1.3.13. 搜索磁盘

下表描述了磁盘的所有搜索选项。

您可以使用 Disk Type 和 Content Type 过滤选项来减少显示的虚拟磁盘数量。

表 1.23. 搜索磁盘

| 属性(资源或资源类型) | 类型 | 描述(参考) |

|---|---|---|

|

| 取决于属性类型 | 与磁盘关联的数据中心的属性。 |

|

| 取决于属性类型 | 与磁盘关联的存储的属性。 |

|

| 字符串 | 标识网络上存储的人类可读名称。 |

|

| 字符串 | 描述磁盘时使用的关键字或文本(可选)。 |

|

| 整数 | 磁盘的虚拟大小。 |

|

| 整数 | 磁盘大小。 |

|

| 整数 | 分配给磁盘的实际大小。 |

|

| 整数 | 创建磁盘的日期。 |

|

| 字符串 |

磁盘是否可以引导。有效值为 |

|

| 字符串 |

磁盘是否能一次连接到多个虚拟机。有效值为 |

|

| 字符串 |

磁盘格式。可以是 |

|

| 字符串 |

磁盘状态。可以是 |

|

| 字符串 |

磁盘的类型。可以是 |

|

| 整数 | 附加磁盘的虚拟机数量。 |

|

| 字符串 | 附加磁盘的虚拟机的名称。 |

|

| 字符串 | 虚拟磁盘强制配额的名称。 |

|

| list | 根据其中一个资源属性对返回的结果进行排序。 |

|

| 整数 | 要显示的结果的页面数。 |

Example

disks: format = cow 和 provisioned_size > 8

这个示例返回带有 QCOW 格式和分配的磁盘大小大于 8 GB 的虚拟磁盘列表。

1.3.14. 搜索卷

下表描述了卷的所有搜索选项。

表 1.24. 搜索卷

| 属性(资源或资源类型) | 类型 | 描述(参考) |

|---|---|---|

|

| 字符串 | 与卷关联的集群名称。 |

|

| 取决于属性类型(示例:名称、描述、注释、架构) | 与卷关联的集群的属性。 |

|

| 字符串 | 标识卷的人类可读名称。 |

|

| 字符串 | 可以是分发、复制、distributed_replicate、stripe 或 distributed_stripe 中的一个。 |

|

| 整数 | 可以是 TCP 或 RDMA 之一。 |

|

| 整数 | 副本数。 |

|

| 整数 | 条带数。 |

|

| 字符串 | 卷的状态。可以是 Up 或 Down 之一。 |

|

| list | 根据其中一个资源属性对返回的结果进行排序。 |

|

| 整数 | 要显示的结果的页面数。 |

Example

volume: transport_type = rdma 和 stripe_count >= 2

这个示例返回有传输类型设置为 RDMA 的卷列表,以及 2 个或更多条带。

1.3.15. 搜索虚拟机

下表描述了虚拟机的所有搜索选项。

目前,Network Label, Custom Emulated Machine, 和 Custom CPU Type 属性不支持搜索参数。

表 1.25. 搜索虚拟机

| 属性(资源或资源类型) | 类型 | 描述(参考) |

|---|---|---|

|

| 取决于属性类型 | 与虚拟机关联的主机的属性。 |

|

| 取决于属性类型 | 与虚拟机关联的模板的属性。 |

|

| 取决于属性类型 | 与虚拟机关联的事件的属性。 |

|

| 取决于属性类型 | 与虚拟机关联的用户的属性。 |

|

| 取决于属性类型 | 与虚拟机关联的存储设备的属性。 |

|

| 取决于属性类型 | 与虚拟机关联的 vNIC 属性。 |

|

| 字符串 | 虚拟机的名称。 |

|

| list | 虚拟机的可用性。 |

|

| 整数 | 虚拟机的 IP 地址。 |

|

| 整数 | 虚拟机运行了几分钟的时间。 |

|

| 字符串 | 对这些机器进行分组的域(通常为 Active Directory 域)。 |

|

| 字符串 | 创建虚拟机时选择的操作系统。 |

|

| Date | 创建虚拟机的日期。 |

|

| 字符串 | 标识网络上的虚拟机的唯一名称。 |

|

| 整数 | 使用的处理能力百分比。 |

|

| 整数 | 使用的内存百分比。 |

|

| 整数 | 使用的网络的百分比。 |

|

| 整数 | 定义的最大内存。 |

|

| 字符串 | 当前在虚拟机上安装的应用程序。 |

|

| list | 虚拟机所属的集群。 |

|

| list | 虚拟机所属的虚拟机池。 |

|

| 字符串 | 当前登录到虚拟机的用户的名称。 |

|

| list | 虚拟机所属的标签。 |

|

| 字符串 | 虚拟机所属的数据中心。 |

|

| list | 虚拟机类型(服务器或桌面)。 |

|

| 字符串 | 与虚拟机关联的配额名称。 |

|

| 字符串 | 描述虚拟机的关键字或文本,可以选择创建虚拟机时使用。 |

|

| list | 根据其中一个资源属性对返回的结果进行排序。 |

|

| 整数 | 要显示的结果的页面数。 |

|

| 布尔值 | 虚拟机有待处理的配置更改。 |

Example

VMs: template.name = Win* and user.name = ""

本例返回其基础模板名称以 Win 开头的虚拟机列表,并分配给任何用户。

Example

VM: cluster = Default and os = windows7

这个示例返回属于 Default 集群且正在运行 Windows 7 的虚拟机列表。

1.3.16. 搜索池

下表描述了池的所有搜索选项。

表 1.26. 搜索池

| 属性(资源或资源类型) | 类型 | 描述(参考) |

|---|---|---|

|

| 字符串 | 池的名称。 |

|

| 字符串 | 池的描述。 |

|

| list | 池的类型。 |

|

| list | 根据其中一个资源属性对返回的结果进行排序。 |

|

| 整数 | 要显示的结果的页面数。 |

Example

pool: type = automatic

这个示例返回了类型为 automatic 的池列表。

1.3.17. 搜索模板

下表描述了模板的所有搜索选项。

表 1.27. 搜索模板

| 属性(资源或资源类型) | 类型 | 描述(参考) |

|---|---|---|

|

| 字符串 | 与模板关联的虚拟机的属性。 |

|

| 字符串 | 与模板关联的主机的属性。 |

|

| 字符串 | 与模板关联的事件的属性。 |

|

| 字符串 | 与模板关联的用户的属性。 |

|

| 字符串 | 模板的名称。 |

|

| 字符串 | 模板的域。 |

|

| 字符串 | 操作系统的类型。 |

|

| 整数 | 创建模板的日期。 日期格式是 mm/dd/yy。 |

|

| 整数 | 从模板创建的虚拟机数量。 |

|

| 整数 | 定义的内存。 |

|

| 字符串 | 模板的描述。 |

|

| 字符串 | 模板的状态。 |

|

| 字符串 | 与模板关联的集群。 |

|

| 字符串 | 与模板关联的数据中心。 |

|

| 字符串 | 与模板关联的配额。 |

|

| list | 根据其中一个资源属性对返回的结果进行排序。 |

|

| 整数 | 要显示的结果的页面数。 |

Example

template: Events.severity >= normal and Vms.uptime > 0

本例返回模板列表,其中事件是从模板派生的虚拟机上发生正常或更大严重性的事件,并且虚拟机仍在运行。

1.3.18. 搜索用户

下表描述了用户的所有搜索选项。

表 1.28. 搜索用户

| 属性(资源或资源类型) | 类型 | 描述(参考) |

|---|---|---|

|

| 取决于属性类型 | 与用户关联的虚拟机的属性。 |

|

| 取决于属性类型 | 与用户关联的主机的属性。 |

|

| 取决于属性类型 | 与用户关联的模板的属性。 |

|

| 取决于属性类型 | 与用户关联的事件的属性。 |

|

| 字符串 | 用户名称。 |

|

| 字符串 | 用户的姓氏。 |

|

| 字符串 | 用户的唯一名称。 |

|

| 字符串 | 用户所属的部门。 |

|

| 字符串 | 用户所属的组。 |

|

| 字符串 | 用户标题。 |

|

| 字符串 | 用户的状态。 |

|

| 字符串 | 用户的角色。 |

|

| 字符串 | 用户所属的标签。 |

|

| 字符串 | 用户所属的池。 |

|

| list | 根据其中一个资源属性对返回的结果进行排序。 |

|

| 整数 | 要显示的结果的页面数。 |

Example

Users: Events.severity > normal and Vms.status = up or Vms.status = pause

此示例返回一个用户列表,其中事件超过正常严重性的事件已发生在虚拟机,并且虚拟机仍在运行中;或者用户的虚拟机已暂停。

1.3.19. 搜索事件

下表描述了可用于搜索事件的所有搜索选项。根据情况提供许多选项的自动完成功能。

表 1.29. 搜索事件

| 属性(资源或资源类型) | 类型 | 描述(参考) |

|---|---|---|

|

| 取决于属性类型 | 与事件关联的虚拟机的属性。 |

|

| 取决于属性类型 | 与事件关联的主机的属性。 |

|

| 取决于属性类型 | 与事件关联的模板的属性。 |

|

| 取决于属性类型 | 与事件关联的用户的属性。 |

|

| 取决于属性类型 | 与事件关联的集群的属性。 |

|

| 取决于属性类型 | 与事件关联的卷的属性。 |

|

| list | 事件的类型。 |

|

| list | 事件的严重性: Warning/Error/Normal。 |

|

| 字符串 | 事件类型的描述。 |

|

| list | 事件发生一天。 |

|

| 字符串 | 与事件关联的用户名。 |

|

| 字符串 | 与事件关联的主机。 |

|

| 字符串 | 与事件关联的虚拟机。 |

|

| 字符串 | 与事件关联的模板。 |

|

| 字符串 | 与事件关联的存储。 |

|

| 字符串 | 与事件关联的数据中心。 |

|

| 字符串 | 与事件关联的卷。 |

|

| 整数 | 事件的标识号。 |

|

| list | 根据其中一个资源属性对返回的结果进行排序。 |

|

| 整数 | 要显示的结果的页面数。 |

Example

Events: Vms.name = testdesktop and Hosts.name = gonzo.example.com

本例返回事件列表,其中事件发生在名为 testdesktop 的虚拟机上,同时在主机 gonzo.example.com 上运行。

1.4. 书签

1.4.1. 将查询字符串保存为书签

书签可用于记住搜索查询,并与其他用户共享。

流程

- 在搜索栏中输入所需的搜索查询,并执行搜索。

- 点搜索栏右侧的星形形状的书签按钮。此时将打开 New Bookmark 窗口。

- 输入书签的 Name。

- 如果需要,编辑 Search string 字段。

- 点击 OK。

点击标题栏中的 书签 图标

来查找并选择书签。

来查找并选择书签。

1.4.2. 编辑书签

您可以修改书签的名称和搜索字符串。

流程

-

点击标题栏中的 书签 图标

。

。

- 选择书签并点击 Edit。

- 根据需要更改 Name 和 Search 字符串字段。

- 点击 OK。

1.4.3. 删除书签

当不再需要书签时,将其删除。

流程

-

点击标题栏中的 书签 图标

。

。

- 选择书签并单击 删除。

- 点击 OK。

1.5. Tags

1.5.1. 使用标签来自定义 Red Hat Virtualization

在为您的要求设置并配置了 Red Hat Virtualization 平台后,您可以使用标签自定义它的工作方式。标记允许将系统资源分组或类别。当虚拟化环境中存在很多对象时,这很有用,而管理员想要专注于一组特定的对象。

本节论述了如何创建和编辑标签,将它们分配到主机或虚拟机,并使用标签作为条件进行搜索。可将标签按照与结构匹配的层次结构来排列,以满足企业的需求。

要创建、修改和删除管理门户标签,请点击标题栏中的 标签 图标

。

。

1.5.2. 创建标签

创建标签,以便您可以使用标签过滤搜索结果。

流程

-

点标题栏中的 标签 图标(

)。

)。

- 单击 Add 以创建新标签,或者选择标签,然后单击 New 以创建下级标签。

- 输入新标签的名称和描述。

- 点击 OK。

1.5.3. 修改标签

您可以编辑标签的名称和描述。

修改标签

-

点标题栏中的 标签 图标(

)。

)。

- 选择要修改的标签并点击 Edit。

- 根据需要更改 Name 和 Description 字段。

- 点击 OK。

1.5.4. 删除标签

当不再需要某个标签时,将它删除。

流程

-

点标题栏中的 标签 图标(

)。

)。

- 选择您要删除的标签,然后单击 Remove。消息会警告,删除标签也会同时删除标签的所有后代。

- 点击 OK。

您已删除标签及其所有子代。该标签也会从它所附加的所有对象中删除。

1.5.5. 为对象添加和删除标签

您可以分配标签到并从主机、虚拟机和用户中删除标签。

流程

- 选择您要标记或取消标记的对象。

-

点 More Actions (

),然后点 Assign Tags。

),然后点 Assign Tags。

- 选中复选框,以分配标签到对象,或者清除要从对象中分离标签的复选框。

- 点击 OK。

指定的标签现在将添加或删除为所选对象的自定义属性。

1.5.6. 使用标签搜索对象

使用 tag 作为属性以及所需值或值集作为搜索条件输入搜索查询。

带有指定条件的对象列在结果列表中。

如果您在搜索对象时使用 tag 作为属性以及不相等运算符 (!=),例如 Host: Vms.tag!=server1,则结果列表不包括没有带有 tag 的对象。

1.5.7. 使用标签自定义主机

您可以使用标签存储主机的相关信息。然后,您可以基于标签搜索主机。有关搜索的更多信息,请参阅 搜索。

流程

- 单击 Compute → Hosts 并选择一个主机。

-

点 More Actions (

),然后点 Assign Tags。

),然后点 Assign Tags。

- 选中适用标签的复选框。

- 点击 OK。

您已添加有关主机的额外可搜索信息作为标签。

第 2 章 管理资源

2.1. 服务质量

Red Hat Virtualization 允许您定义服务质量条目,对环境中资源的输入和输出、处理和网络功能提供精细的控制。服务条目的质量在数据中心级别上定义,并分配到集群和存储域下创建的配置集。然后,这些配置集被分配到集群中独立的资源和创建配置集的存储域中。

2.1.1. 存储服务质量

存储服务质量为存储域的虚拟磁盘定义最大吞吐量级别和输出操作级别。通过为虚拟磁盘分配存储服务质量,您可以对存储域的性能进行微调,并防止与一个虚拟磁盘关联的存储操作影响到同一存储域上托管的其他虚拟磁盘的可用存储功能。

2.1.1.1. 创建存储服务质量服务条目

流程

- 单击 Compute → Data Centers。

- 点数据中心的名称。这会打开详情视图。

- 点 QoS 选项卡。

- 在 Storage 下,单击 New。

- 为服务质量输入输入 QoS Name 和 Description。

选择以下选项之一来指定服务的吞吐量质量:

- None

- Total - 在 MB/s 字段中输入允许的最大吞吐量。

- Read/Write - 在左面的 MB/s 字段中输入读操作的最大允许吞吐量,在右面的 MB/s 字段中输入写操作的最大吞吐量。

点击其中一个单选按钮来指定服务的输入和输出(IOps)质量:

- None

- total - 在 IOps 字段中,输入数上限和输出操作数每秒输入数。

- Read/Write - 在左面的 IOps 字段中输入允许的最大输入操作数,在右面的 IOps 字段中输入每秒允许的最大操作数。

- 点击 OK。

您已创建了服务条目的存储质量,并根据属于数据中心的数据存储域中的该条目创建磁盘配置文件。

2.1.1.2. 删除存储服务质量服务条目

删除现有存储服务质量条目。

流程

- 单击 Compute → Data Centers。

- 点数据中心的名称。这会打开详情视图。

- 点 QoS 选项卡。

- 在 Storage 下,选择 storage quality of service 条目,再单击 Remove。

- 点击 OK。

如果有任何磁盘配置集基于该条目,则这些配置集的服务条目的存储质量会自动设置为 [无限]。

2.1.2. 虚拟机网络服务质量

虚拟机网络服务质量的功能允许您创建配置文件来限制单个虚拟网络接口控制器的入站和出站流量。通过此功能,您可以限制多个层中的带宽,从而控制网络资源的消耗。

2.1.2.1. 创建虚拟机网络服务质量服务条目

在应用到虚拟网络接口控制器(vNIC)配置集(也称为虚拟机网络接口接口配置文件)时,创建用于注册网络流量的虚拟机网络服务质量。

创建虚拟机网络服务质量服务条目

- 单击 Compute → Data Centers。

- 点数据中心的名称。这会打开详情视图。

- 点 QoS 选项卡。

- 在 VM Network 下,单击 New。

- 为虚拟机网络服务质量输入 Name。

- 输入 Inbound 和 Outbound 网络流量的限制。

- 点击 OK。

您已创建了虚拟机网络服务质量,它可在虚拟网络接口控制器中使用。

2.1.2.2. New Virtual Machine Network QoS 和 Edit Virtual Machine Network QoS Windows 中的设置说明

虚拟机网络服务质量设置允许您在三个不同级别上为入站和出站流量配置带宽限制。

表 2.1. 虚拟机网络 QoS 设置

| 字段名称 | Description |

|---|---|

| 数据中心 | 要添加虚拟机网络 QoS 策略的数据中心。此字段会根据所选数据中心自动配置。 |

| Name | 代表 Manager 中的虚拟机网络 QoS 策略的名称。 |

| 入站 | 应用到入站流量的设置。选择或取消选择 Inbound 复选框来启用或禁用这些设置。

|

| 出站 | 应用到出站流量的设置。选择或清除 Outbound 复选框,以启用或禁用这些设置。

|

要更改 Average、Peak 或 Burst 字段允许的最大值,使用 engine-config 命令更改 MaxAverageNetworkQoSValue、MaxPeakNetworkQoSValue 或 MaxBurstNetworkQoSValue 配置键的值。您必须重新启动 ovirt-engine 服务,才能使任何更改生效。例如:

# engine-config -s MaxAverageNetworkQoSValue=2048 # systemctl restart ovirt-engine

2.1.2.3. 删除虚拟机网络服务质量服务条目

删除服务条目的现有虚拟机网络质量。

流程

- 单击 Compute → Data Centers。

- 点数据中心的名称。这会打开详情视图。

- 点 QoS 选项卡。

- 在 VM Network 下,选择虚拟机网络质量的 service 条目,再单击 Remove。

- 点击 OK。

2.1.3. 主机网络服务质量

主机网络质量配置主机上的网络,从而通过物理接口控制网络流量。主机网络服务质量可通过控制同一物理网络接口控制器上的网络资源消耗来微调网络性能。这有助于防止一个网络使其他网络附加到同一物理网络接口控制器时,因为负载过重的流量不再起作用。通过配置主机网络质量服务,这些网络现在可以在同一物理网络接口控制器上正常工作,而不会出现各种问题。

2.1.3.1. 创建主机网络服务质量服务条目

创建主机网络服务质量服务条目。

流程

- 单击 Compute → Data Centers。

- 点数据中心的名称。这会打开详情视图。

- 点 QoS 选项卡。

- 在 主机网络下,单击新建。

- 输入 Qos Name,以及服务质量条目的描述。

- 为 Weighted Share、Rate Limit [Mbps] 和 Committed Rate [Mbps] 输入所需的值。

- 点击 OK。

2.1.3.2. New Host Network Quality of Service and Edit Host Network Quality of Service Windows 中的内容

通过主机网络服务质量设置,您可以为出站流量配置带宽限制。

表 2.2. 主机网络 QoS 设置

| 字段名称 | Description |

|---|---|

| 数据中心 | 要添加到主机网络 QoS 策略的数据中心。此字段会根据所选数据中心自动配置。 |

| QoS Name | 代表 Manager 中的主机网络 QoS 策略的名称。 |

| Description | 主机网络 QoS 策略的描述。 |

| 出站 | 应用到出站流量的设置。

|

要更改 Rate Limit [Mbps] 或 Committed Rate [Mbps] 字段允许的最大值,请使用 engine-config 命令更改 MaxAverageNetworkQoSValue 配置键的值。您必须重新启动 ovirt-engine 服务,才能使更改生效。例如:

# engine-config -s MaxAverageNetworkQoSValue=2048 # systemctl restart ovirt-engine

2.1.3.3. 删除主机网络服务质量条目

删除现有的服务质量。

流程

- 单击 Compute → Data Centers。

- 点数据中心的名称。这会打开详情视图。

- 点 QoS 选项卡。

- 在 Host Network 下,选择主机网络服务质量服务条目,再单击 Remove。

- 提示时点 确定。

2.1.4. CPU 服务质量

CPU 服务质量定义虚拟机可在其上运行的主机上的最大处理能力,以对该主机可用的总处理能力百分比表示。通过为虚拟机分配 CPU 质量,您可以防止集群中的一个虚拟机上的工作负载影响集群中可供其他虚拟机的处理资源。

2.1.4.1. 创建 CPU 服务质量条目

创建服务条目的 CPU 质量。

流程

- 单击 Compute → Data Centers。

- 点数据中心的名称。这会打开详情视图。

- 点 QoS 选项卡。

- 在 CPU 下,单击 New。

- 为服务质量输入输入 QoS Name 和 Description。

-

在 Limit (%) 字段中输入服务条目允许的最大处理能力。不要包含

%符号。 - 点击 OK。

您已创建了服务条目的 CPU 质量,并可以根据属于该数据中心的集群中的该条目创建 CPU 配置集。

2.1.4.2. 删除 CPU 服务质量条目

删除服务条目的现有 CPU 质量。

流程

- 单击 Compute → Data Centers。

- 点数据中心的名称。这会打开详情视图。

- 点 QoS 选项卡。

- 在 CPU 下,选择 CPU 质量的服务条目,然后单击 Remove。

- 点击 OK。

如果任何 CPU 配置集都基于该条目,则这些配置集的服务条目的 CPU 质量会自动设置为 [unlimited]。

2.2. Data Centers

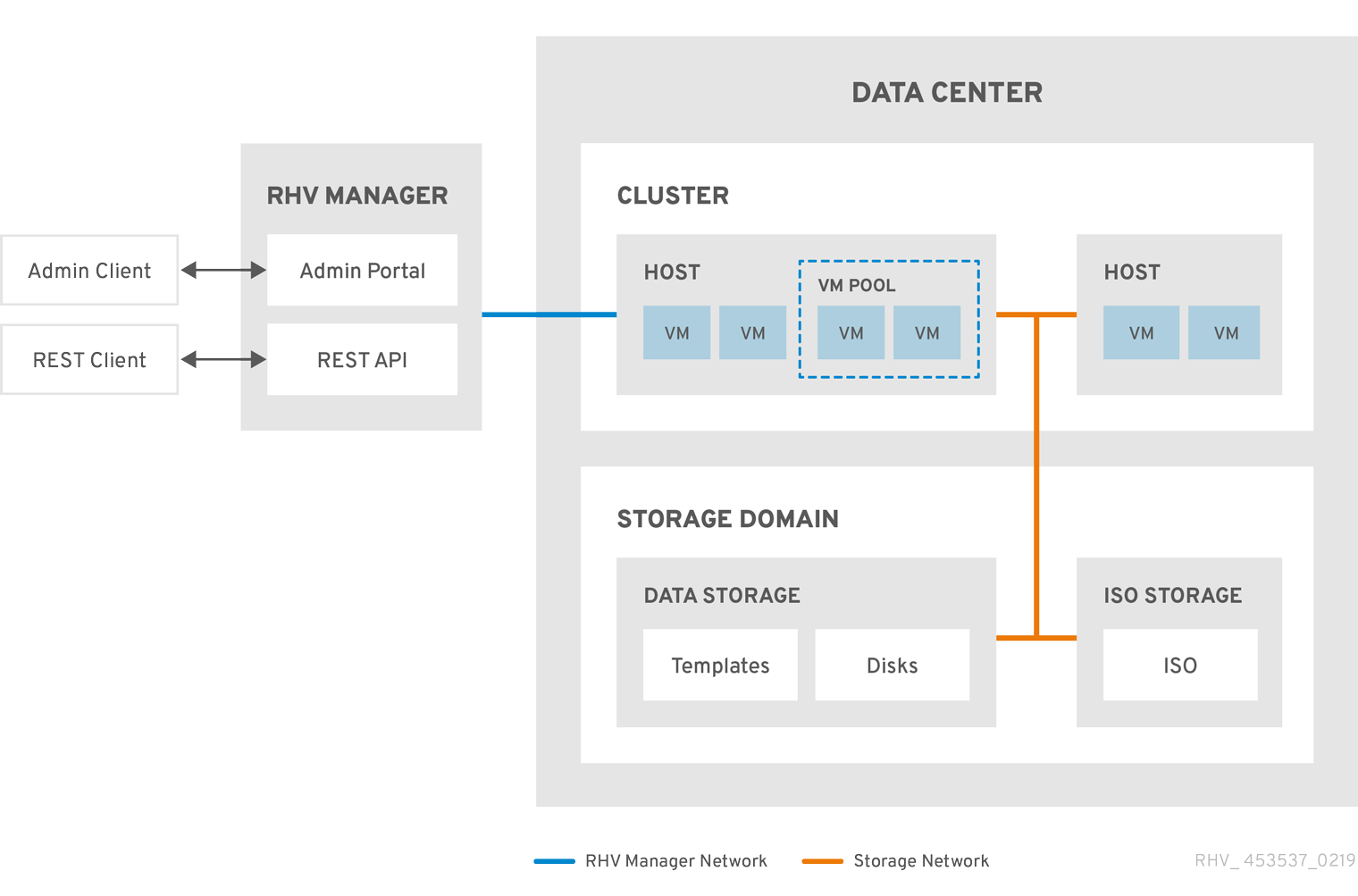

2.2.1. 数据中心介绍

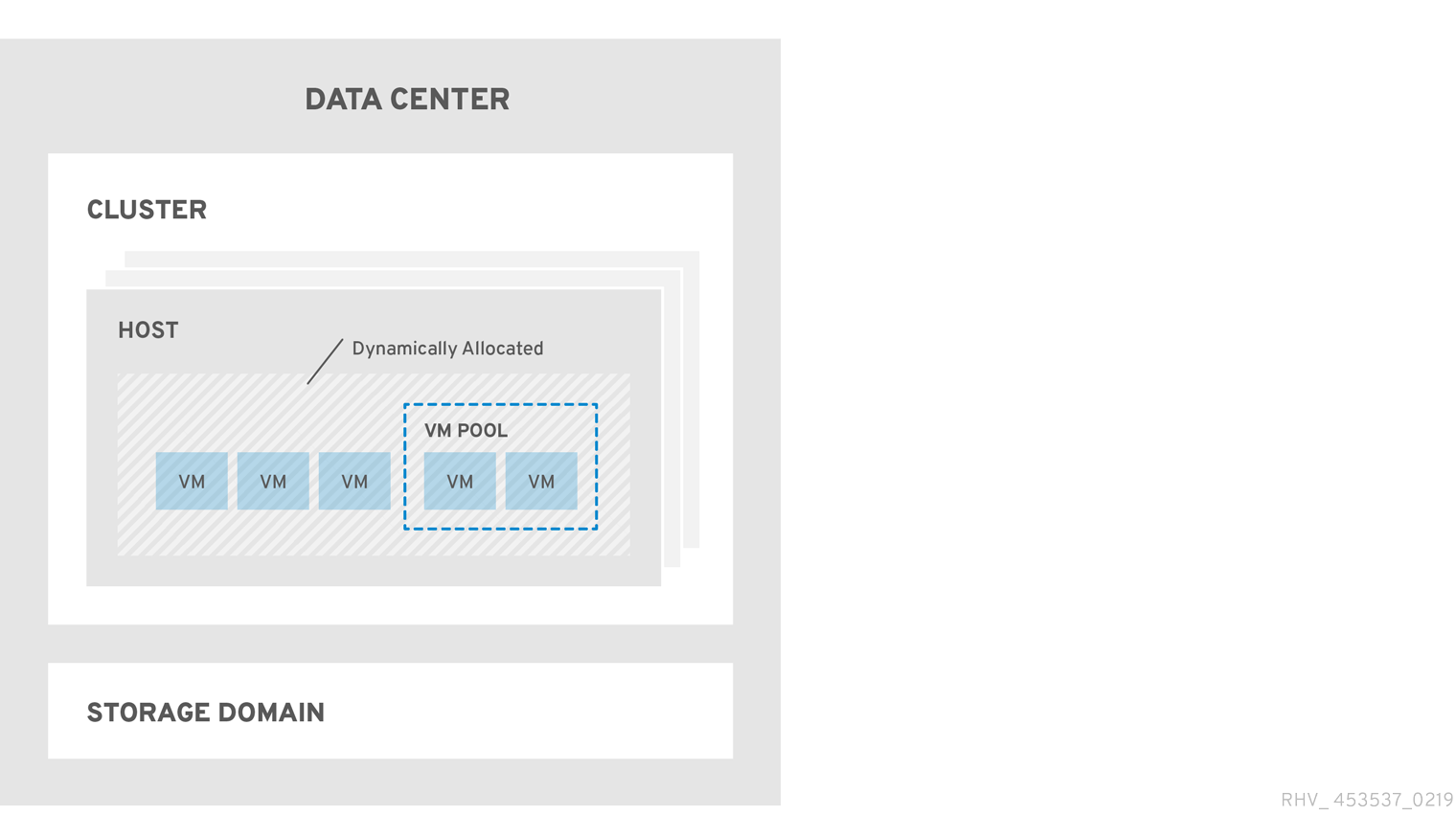

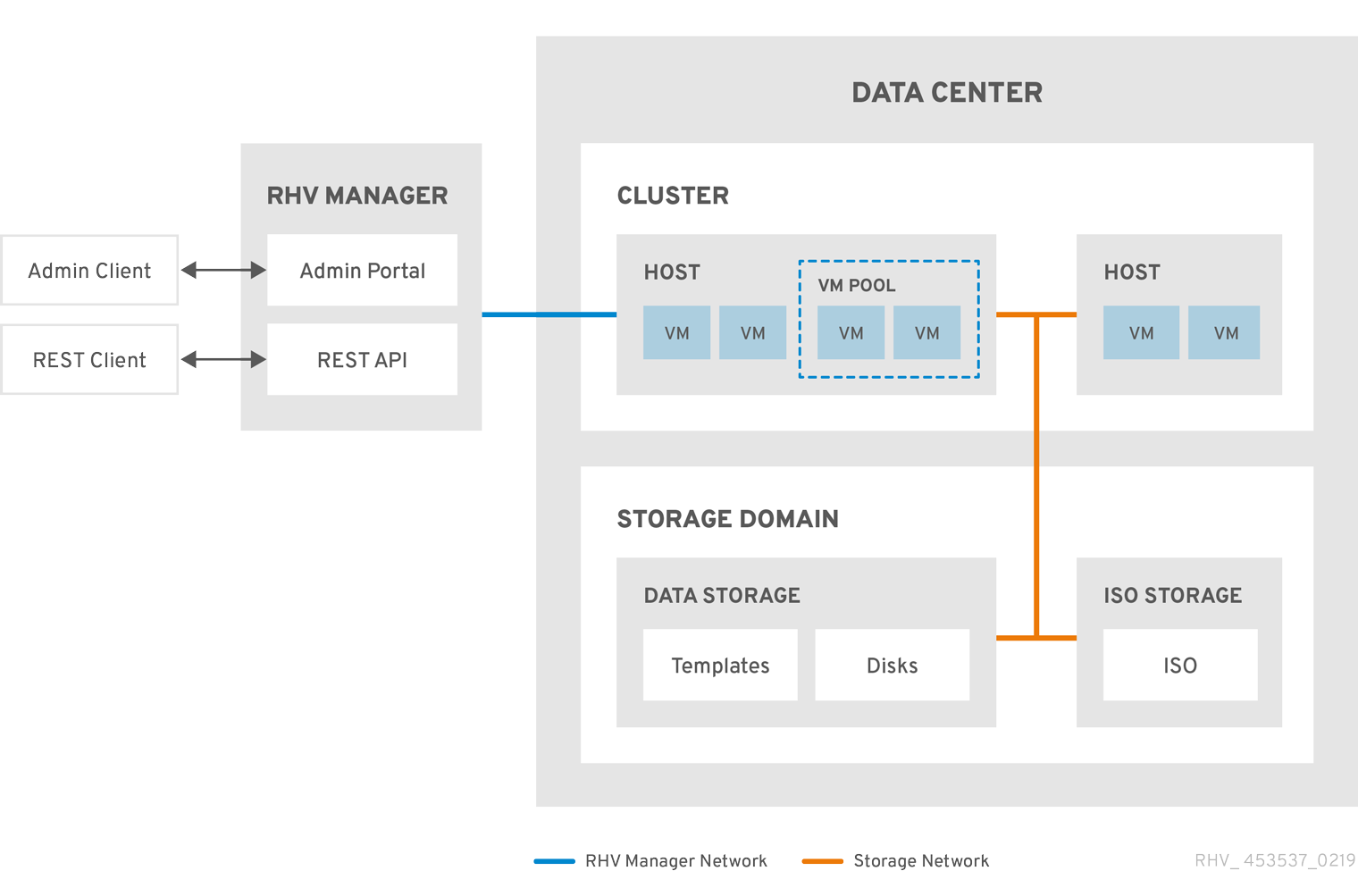

数据中心是一个逻辑实体,用于定义特定环境中使用的资源集合。数据中心被视为容器资源,其中由逻辑资源组成,其格式为集群和主机;网络资源,格式为逻辑网络和物理 NIC;以及存储资源,格式为存储域。

数据中心可以包含多个集群,可以包含多个主机 ; 可以关联多个存储域;它可以支持每个主机上的多个虚拟机。Red Hat Virtualization 环境可以包含多个数据中心;数据中心基础架构允许您分别保持这些中心。

所有数据中心都通过单一管理门户管理。

图 2.1. Data Centers

Red Hat Virtualization 在安装过程中创建一个默认数据中心。您可以配置默认数据中心,或者相应地设置新命名数据中心。

2.2.2. 存储池管理程序

存储池管理程序 (SPM) 是提供给数据中心中某一主机的角色,使其能够管理数据中心的存储域。SPM 实体可以在数据中心的任何主机上运行;红帽虚拟化管理器将角色授予其中一个主机。SPM 不会从其标准操作中排除主机;作为 SPM 运行的主机仍然可以托管虚拟资源。

SPM 实体通过协调存储域的元数据来控制对存储的访问。这包括创建、删除和操作虚拟磁盘(镜像)、快照和模板,以及为稀疏块设备(在 SAN 上)分配存储。这是一个拍它的责任:只有一个主机可以是一个数据中心的 SPM,以确保元数据的完整性。

Red Hat Virtualization Manager 确保 SPM 始终可用。如果 SPM 主机在访问存储时遇到问题,则管理器会将 SPM 角色移到其他主机。当 SPM 启动时,它会确保它是唯一授予该角色的主机,因此它将获得以存储为中心的租用。这个过程可能需要一些时间。

2.2.3. SPM 优先级

SPM 角色使用部分主机的可用资源。主机的 SPM 优先级设置将更改被分配 SPM 角色的主机的可能性:在具有高 SPM 优先级的主机将在主机具有低 SPM 优先级前分配 SPM 角色。具有低 SPM 优先级的主机上的关键虚拟机不必与主机资源的 SPM 操作相交。

您可以在 Edit Host 窗口的 SPM 选项卡中更改主机的 SPM 优先级。

2.2.4. 数据中心任务

2.2.4.1. 创建新数据中心

此流程在您的虚拟化环境中创建一个数据中心。数据中心需要一个正常工作的集群、主机和存储域才能运行。

设置 Compatibility Version 后,您无法降低版本号。不支持版本回归。

您可以为集群指定 MAC 池范围。不再支持设置 MAC 池范围。

流程

- 单击 Compute → Data Centers。

- 单击 New。

- 输入数据中心的名称和描述。

- 从下拉菜单中选择 Storage Type、Compatibility Version 和 Quota Mode。

- 点 OK 创建数据中心并打开 Data Center - Guide Me 窗口。

-

Guide Me 窗口列出了需要为数据中心配置的实体。点 Configure Later 按钮配置这些实体或 postpone 配置。通过选择数据中心并点 More Actions (

)来恢复配置,然后点 Guide Me。

)来恢复配置,然后点 Guide Me。

新数据中心将保持未初始化状态,直到为其配置了集群、主机和存储域;使用 Guide Me 来配置这些实体。

2.2.4.2. New Data Center 和 Edit Data Center Windows 中的设置说明

下表描述了新建数据中心和编辑数据中心窗口中显示的数据中心的设置。当您单击 OK 时,无效的条目会在 orange 中列出,从而禁止接受更改。另外,字段提示指定预期的值或值范围。

表 2.3. 数据中心属性

| 字段 | description/Action |

|---|---|

| Name | 数据中心的名称。此文本字段的限制为 40 个字符,且必须是唯一的名称,其中含有大写字母和小写字母、数字、连字符和下划线的任意组合。 |

| Description | 数据中心的描述。建议使用此字段,但不强制设置。 |

| 存储类型 | 选择共享或本地存储类型。 可将不同类型的存储域(iSCSI、NFS、FC、POSIX 和 Gluster)添加到同一数据中心。但是,本地和共享域不能混合使用。 您可在数据中心初始化后更改存储类型。请参阅 更改数据中心存储类型。 |

| 兼容性版本 | Red Hat Virtualization 的版本。 升级 Red Hat Virtualization Manager 后,主机、集群和数据中心可能仍然在更早的版本。在升级数据中心的兼容性等级前,请确保已升级所有主机,然后集群。 |

| 配额模式 | 配额是 Red Hat Virtualization 提供的资源限制工具。选择以下之一:

|

| 注释 | (可选)添加有关数据中心的纯文本注释。 |

2.2.4.3. 重新初始化数据中心:恢复过程

此恢复过程将数据中心的 master 数据域替换为新的 master 数据域。如果 主 数据损坏,您必须重新初始化主数据域。通过重新初始化数据中心,您可以恢复与数据中心关联的所有其他资源,包括集群、主机和非问题存储域。

您可以将任何备份或导出的虚拟机或模板导入到新的 master 数据域中。

流程

- 点 Compute → Data Centers 并选择数据中心。

- 确定附加到数据中心的任何存储域都处于维护模式。

-

点 More Actions (

,然后点 Re-Initialize Data Center。

,然后点 Re-Initialize Data Center。

- 数据中心重新初始化 窗口将列出所有可用的(已达到维护模式;在维护模式中)存储域。点您要添加到数据中心的存储域的单选按钮。

- 选择 Approve operation 复选框。

- 点击 OK。

存储域作为 master 数据域连接到数据中心,并已激活。现在,您可以将任何备份或导出的虚拟机或模板导入到新的 master 数据域中。

2.2.4.4. 删除数据中心

删除数据中心需要活跃的主机。删除数据中心不会删除关联的资源。

流程

- 确保附加到数据中心的存储域处于维护模式。

- 点 Compute → Data Centers 并选择要删除的数据中心。

- 单击 Remove。

- 点击 OK。

2.2.4.5. 强制删除数据中心

如果附加的存储域已损坏或者主机变为 Non Responsive,则数据中心将变为 Non Responsive。您不能在这两种情况下 删除 数据中心。

强制删除 不需要活跃的主机。它还永久删除附加的存储域。

可能需要先销毁损坏的存储域,然后才能强制删除数据中心。

流程

- 点 Compute → Data Centers 并选择要删除的数据中心。

-

点 More Actions (

),然后点 Force Remove。

),然后点 Force Remove。

- 选择 Approve operation 复选框。

- 点 OK

数据中心和附加存储域从 Red Hat Virtualization 环境中永久删除。

2.2.4.6. 更改数据中心存储类型

您可在初始化后更改数据中心的存储类型。这可用于移动虚拟机或模板的数据域。

限制

- 与本地共享 - 对于不含多个主机和多个集群的数据中心,因为本地数据中心不支持它。

- local to Shared - 对于不包含本地存储域的数据中心。

流程

- 单击 Compute → Data Centers,再选择要更改的数据中心。

- 点 Edit。

- 将 Storage Type 更改为所需的值。

- 点击 OK。

2.2.4.7. 更改数据中心兼容性版本

Red Hat Virtualization 数据中心具有兼容性版本。兼容性版本指明了数据中心要与之兼容的 Red Hat Virtualization 版本。数据中心中的所有集群都必须支持所需的兼容性级别。

先决条件

- 要更改数据中心兼容性级别,您必须首先更新数据中心中所有集群和虚拟机的兼容性版本。

流程

- 在管理门户中,点 Compute → Data Centers。

- 选择要更改的数据中心,再单击 Edit。

- 将 Compatibility Version 更改为所需的值。

- 点击 确定。此时会打开 Change Data Center Compatibility Version 确认对话框。

- 点 OK 确认。

2.2.5. 数据中心和存储域

2.2.5.1. 将现有数据域附加到数据中心

未连接的数据域 可以附加到数据中心。可向同一数据中心添加多种类型的共享存储域(iSCSI、NFS、FC、POSIX 和 Gluster)。

流程

- 单击 Compute → Data Centers。

- 点数据中心的名称。这会打开详情视图。

- 点 Storage 选项卡列出已附加到数据中心的存储域。

- 点 Attach Data。

- 选中要附加到数据中心的数据域的复选框。您可以选择多个复选框来附加多个数据域。

- 点击 OK。

数据域已附加到数据中心,并自动激活。

2.2.5.2. 将现有的 ISO 域附加到数据中心

未附加的 ISO 域可以附加到数据中心。ISO 域必须是与数据中心相同的 存储类型。

只能将一个 ISO 域附加到数据中心。

流程

- 单击 Compute → Data Centers。

- 点数据中心的名称。这会打开详情视图。

- 点 Storage 选项卡列出已附加到数据中心的存储域。

- 点 Attach ISO。

- 点相应 ISO 域的单选按钮。

- 点击 OK。

ISO 域连接到数据中心,并自动激活。

2.2.5.3. 将现有导出域附加到数据中心

导出存储域已弃用。存储数据域可以从数据中心取消附加,并导入到同一环境中或不同环境中的其他数据中心。然后,可以将虚拟机、浮动虚拟磁盘和模板从导入的存储域上传到所连接的数据中心。有关 导入存储域的信息,请参阅导入现有存储域。

附加 未连接 的导出域可以附加到数据中心。只能将一个导出域附加到数据中心。

流程

- 单击 Compute → Data Centers。

- 点数据中心的名称。这会打开详情视图。

- 点 Storage 选项卡列出已附加到数据中心的存储域。

- 点 Attach Export。

- 单击相应导出域的单选按钮。

- 点击 OK。

导出域连接到数据中心,并自动激活。

2.2.5.4. 将存储域从数据中心分离

将存储域从数据中心分离开来,将阻止数据中心与该存储域相关联。存储域不会从 Red Hat Virtualization 环境中删除;它可以附加到另一个数据中心。

虚拟机和模板等数据仍然附加到存储域。

虽然可以分离最后一个主存储域,但不建议这样做。

如果分离主存储域,必须重新初始化。

如果重新初始化存储域,您的所有数据都将丢失,存储域可能无法再次找到您的磁盘。

流程

- 单击 Compute → Data Centers。

- 点数据中心的名称。这会打开详情视图。

- 点 Storage 选项卡列出附加到数据中心的存储域。

-

选择要分离的存储域。如果存储域是

Active,请单击 Maintenance。 - 单击 OK 以启动维护模式。

- 单击 Detach。

- 点击 OK。

存储域可能需要几分钟才能从详情视图中消失。

2.3. 集群

2.3.1. 集群简介

集群是共享相同存储域且相同类型的 CPU (Intel 或 AMD)的主机的逻辑分组。如果主机具有不同的 CPU 模型生成,则只使用所有模型中的功能。

系统中的每个集群都必须属于一个数据中心,系统中的每一主机都必须属于一个集群。虚拟机会动态分配到集群中的任何主机,并根据虚拟机中定义的策略在它们之间进行迁移。集群是可定义电源和加载共享策略的最高级别。

属于集群的主机和虚拟机数量分别显示在 Host Count 和 VM Count 下的结果列表中。

集群运行虚拟机或 Red Hat Gluster Storage 服务器。这两个目的是相互排斥的:单个集群无法支持虚拟化和存储主机。

Red Hat Virtualization 在安装过程中在默认数据中心创建一个默认集群。

图 2.2. 集群

2.3.2. 集群任务

有些集群选项不适用于 Gluster 集群。有关在 Red Hat Virtualization 中使用 Red Hat Gluster Storage 的更多信息,请参阅使用 Red Hat Gluster Storage 配置 Red Hat Virtualization。

2.3.2.1. 创建新集群

数据中心可以包含多个集群,一个集群可以包含多个主机。集群中的所有主机都必须具有相同的 CPU 架构。要优化 CPU 类型,请在创建集群时创建主机。创建集群后,您可以使用 引导我按钮配置主机。

流程

- 单击 Compute → Clusters。

- 单击 New。

- 从下拉列表中选择集群将属于 的数据中心。

- 输入集群的名称和描述。

- 从 Management Network 下拉列表中选择一个网络来分配管理网络角色。

- 选择 CPU 架构。

对于 CPU Type,请在要属于此群集的主机中选择最旧的 CPU 处理器系列。CPU 类型按顺序从最旧的到最新的列出。

重要其 CPU 处理器系列的主机早于您为 CPU 类型指定的主机 不能是此集群的一部分。详情请查看 RHEV3 或 RHV4 集群应该设置为哪个 CPU 系列?

- 从下拉列表中选择集群的 FIPS Mode。

- 从下拉列表中选择集群的 Compatibility Version。

- 从下拉列表中选择 Switch Type。

选择 集群中主机的防火墙类型,可以是 Firewalld (默认)或 iptables。

注意只有在具有兼容性版本 4.2 或 4.3 的集群中的 Red Hat Enterprise Linux 7 主机才支持 iptables。您只能将 Red Hat Enterprise Linux 8 主机添加到使用防火墙类型为 firewalld的集群

- 选中 Enable Virt Service 或 Enable Gluster Service 复选框,以定义集群是否用虚拟主机填充或启用了 Gluster 的节点。

- (可选)选择 Enable to set VM Maintenance reason 复选框,以便在从 Manager 关闭虚拟机时启用可选的 reason 字段,让管理员能够为维护提供说明。

- (可选)选择 Enable to set Host maintenance reason 复选框,以便在主机从 Manager 放置到维护模式时启用可选的 reason 字段,让管理员能够针对维护提供说明。

- (可选)选择 /dev/hwrng source (外部硬件设备)复选框来指定集群中所有主机要使用的随机数生成器设备。默认启用 /dev/urandom 源 (Linux 提供的设备)。

- 单击 Optimization 选项卡,以选择集群的内存页面共享阈值,并选择性地在集群中的主机上启用 CPU 线程处理和内存膨胀。

- 点击 Migration Policy 选项卡定义集群的虚拟机迁移策略。

- 点 Scheduling Policy 选项卡,以选择性地配置调度策略,配置调度程序优化设置,为集群中的主机启用可信服务,启用 HA Reservation,然后选择序列号策略。

- 点击 Console 选项卡可以选择性地覆盖全局 SPICE 代理(如果有),并为集群中的主机指定 SPICE 代理地址。

- 点击 隔离策略 选项卡在集群中启用或禁用隔离,然后选择隔离选项。

- 单击 MAC Address Pool 选项卡,为集群指定默认池的 MAC 地址池。有关创建、编辑或删除 MAC 地址池的更多信息,请参阅 MAC 地址池。

- 点 OK 创建集群并打开 Cluster - Guide Me 窗口。

-

Guide Me 窗口列出了需要为集群配置的实体。点 Configure Later 按钮配置这些实体或 postpone 配置。通过选择集群并点 More Actions (

)来恢复配置,然后点 Guide Me。

)来恢复配置,然后点 Guide Me。

2.3.2.2. 常规集群设置说明

下表描述了新集群和编辑集群窗口中常规选项卡的设置。当您单击 OK 时,无效的条目会在 orange 中列出,从而禁止接受更改。另外,字段提示指定预期的值或值范围。

表 2.4. 常规集群设置

| 字段 | description/Action |

|---|---|

| 数据中心 | 将包含集群的数据中心。必须在添加集群前创建数据中心。 |

| Name | 集群的名称。此文本字段的限制为 40 个字符,且必须是唯一的名称,其中含有大写字母和小写字母、数字、连字符和下划线的任意组合。 |

| 描述/评论 | 集群的描述或其他备注。建议使用这些字段,但不强制要求。 |

| 管理网络 | 将被分配管理网络角色的逻辑网络。默认为 ovirtmgmt。如果迁移网络没有正确附加到源或目标主机,则此网络也将用于迁移虚拟机。 在现有集群中,只有使用详情视图中的 Logical Networks 标签页中的 Manage Networks 按钮可以更改管理网络。 |

| CPU 架构 | 集群的 CPU 架构。集群中的所有主机都必须运行您指定的架构。不同的 CPU 类型取决于选择哪个 CPU 架构。

|

| CPU Type | 集群中最旧的 CPU 系列。有关 CPU 类型列表,请参阅《 规划和前提条件指南》 中的 CPU 要求。在不发生重大中断的情况下创建集群后,您无法更改它。将 CPU 类型设置为集群中最旧的 CPU 模型。只能使用所有模型中的功能。对于 Intel 和 AMD CPU 类型,列出的 CPU 型号从最旧的到最新状态的顺序排列。 |

| 芯片组/固件类型 | 只有当集群的 CPU 架构 设置为 x86_64 时,此设置才可用。此设置指定芯片组和固件类型。选项是:

如需更多信息,请参阅管理指南中的 UEFI 和 Q35 芯片组。 |

| 使用 Bios 将现有 VM/Templates 从 1440fx 改为 Q35 Chipset | 当集群的芯片组从 I440FX 改为 Q35 时,选择此复选框来更改现有工作负载。 |

| FIPS 模式 | 集群使用的 FIPS 模式。集群中的所有主机都必须运行您指定的 FIPS 模式,或者它们将无法操作。

|

| 兼容性版本 | Red Hat Virtualization 的版本。您将无法选择比为数据中心指定的版本更早的版本。 |

| 切换类型 | 集群使用的交换机类型。Linux Bridge 是标准 Red Hat Virtualization 交换机。OVS 支持 Open vSwitch 网络功能。 |

| 防火墙类型 | 指定集群中主机的防火墙类型,即 firewalld (默认)或 iptables。只有在具有兼容性版本 4.2 或 4.3 的集群中的 Red Hat Enterprise Linux 7 主机才支持 iptables。您只能将 Red Hat Enterprise Linux 8 主机添加到类型为 firewalld 的集群中。如果更改现有集群的防火墙类型,您必须重新安装集群中的所有主机以应用更改。 |

| 默认网络提供程序 | 指定集群要使用的默认外部网络供应商。如果您选择 Open Virtual Network (OVN),则添加到集群的主机会自动配置为与 OVN 供应商通信。 如果更改默认网络供应商,您必须重新安装集群中的所有主机以应用更改。 |

| 最大日志内存阈值 |

以百分比或绝对值(以 MB 为单位)形式指定最大内存消耗的日志记录阈值。如果主机的内存用量超过百分比,或者主机可用内存低于写值,则会记录消息。默认值为 |

| 启用 Virt Service | 如果选中此复选框,则此集群中的主机将用于运行虚拟机。 |

| 启用 Gluster 服务 | 如果选中此复选框,则此集群中的主机将用作 Red Hat Gluster Storage Server 节点,而不用于运行虚拟机。 |

| 导入现有的 gluster 配置 | 只有选择了 Enable Gluster Service 单选按钮时,此复选框才可用。通过此选项,您可以将当前启用了 Gluster 的集群及其所有附加的主机导入到 Red Hat Virtualization Manager。 集群中被导入的每个主机都需要以下选项:

|

| 额外的随机数字生成器源 | 如果选中了复选框,集群中的所有主机都有额外的随机数生成器设备。这可实现从随机数生成器设备到虚拟机传递熵。 |

| Gluster Tuned 配置集 | 只有选择了 Enable Gluster Service 复选框时,此复选框才可用。此选项指定 virtual-host 调优配置文件,以便提高脏内存页面的主动写回,这将使主机性能受益。 |

2.3.2.3. 优化设置说明

内存注意事项

内存页面共享可让虚拟机利用其他虚拟机中未使用的内存,最多使用 200% 的分配内存。此过程基于您 Red Hat Virtualization 环境中的虚拟机不会全部同时运行容量,允许将未使用的内存临时分配给特定虚拟机。

CPU 注意事项

对于非 CPU 密集型工作负载,您可以使用大于主机内核数(单个虚拟机的处理器内核数)的处理器内核总数来运行虚拟机。可以实现以下优点:

- 您可以运行更多虚拟机,从而降低硬件要求。

- 您可以使用原本无法实现的 CPU 拓扑配置虚拟机,例如,虚拟内核的数量在主机内核数和主机线程数量之间。

- 为了获得最佳性能,尤其是 CPU 密集型工作负载,您应该在虚拟机中使用与主机中相同的拓扑,因此主机和虚拟机预计同样的缓存使用量。主机启用了超线程后,QEMU 会将主机的超线程视为内核,因此虚拟机不知道它在具有多个线程的单一核心上运行。此行为可能会影响虚拟机的性能,因为实际对应于主机核心中的超线程的虚拟核心可能会与同一主机核心中的另一个超线程共享一个缓存,而虚拟机则将其视为一个单独的核心。

下表描述了新集群和编辑集群窗口中优化选项卡的设置。

表 2.5. 优化设置

| 字段 | description/Action |

|---|---|

| Memory Optimization |

|

| CPU 线程 | 选择 Count Threads As Cores 复选框可让主机运行虚拟机,处理器内核总数大于主机中的内核数(单个虚拟机的处理器内核数不得超过主机中的内核数)。 选择了此复选框后,公开的主机线程将被视为虚拟机可以使用的内核。例如,一个有 24 个内核,每个内核有 2 个线程的核系统(总共 48 个线程)可以运行最多 48 个虚拟机,用于计算主机 CPU 负载的算法会与潜在的内核的两倍相比。 |

| 内存 Balloon | 选择 Enable Memory Balloon Optimization 复选框可在此集群中运行的虚拟机上启用内存过量使用。选择了此复选框后,内存过量使用管理器(MoM)会尽可能启动膨胀,但会限制每个虚拟机的保证内存大小。

要运行气球功能,虚拟机需要有一个带有相关驱动程序的气球设备。每个虚拟机都包含 balloon 设备,除非特别删除。此集群中的每个主机在状态更改为 务必要清楚,在某些情况下,ballooning 可能会与 KSM 冲突。在这种情况下,MoM 将尝试调整气球的大小,以最大程度减少冲突。此外,在某些情况下,ballooning 可能会导致虚拟机的最优性能。建议管理员小心使用膨胀优化。 |

| KSM 控制 | 选择 启用 KSM 复选框可让 MoM在需要时运行 Kernel Same-page Merging (KSM),并且当它生成内存可节省能降低其 CPU 的成本时。 |

2.3.2.4. 迁移策略设置说明

迁移策略定义了在主机发生故障时实时迁移虚拟机的条件。这些条件包括迁移期间虚拟机的停机时间、网络带宽以及虚拟机优先级方式。

表 2.6. 迁移策略详细说明

| 策略 | Description |

|---|---|

| Cluster default (Minimal downtime) |

|

| Minimal downtime | 允许虚拟机在典型的情况下迁移的策略。虚拟机不应遇到任何显著的停机时间。如果虚拟机迁移经过长时间后还没有被聚合,则迁移过程会被终止(取决于 QEMU 的迭代,最长为 500 millisecond)。客户机代理 hook 机制已启用。 |

| post-copy migration | 使用后复制迁移时,将暂停源主机上的迁移虚拟机 vCPU,仅传输最小内存页面,激活目标主机上的虚拟机 vCPU,并在虚拟机运行目标时传输其余内存页面。 后复制策略首先尝试预复制,以验证是否可能发生聚合。如果虚拟机迁移在很长时间后没有聚合,迁移会切换到后复制。 这可显著减少迁移的虚拟机停机时间,还可以确保无论源虚拟机的内存页面变化速度如何快。对于迁移大量连续使用的虚拟机来说,这是最佳选择,无法使用标准预复制迁移进行迁移。 此策略的缺点在于,在复制后阶段,虚拟机可能会显著下降,因为主机之间缺少内存部分传输。 警告 如果在完成后复制进程前网络连接中断,管理器将暂停,然后终止正在运行的虚拟机。如果虚拟机可用性至关重要,或者迁移网络不稳定,请不要使用复制后迁移。 |

| 如果需要,挂起工作负载 | 允许虚拟机在大多数情况下迁移的策略,包括运行繁重工作负载的虚拟机。因此,与某些其他设置相比,虚拟机可能会出现停机时间更大。迁移可能仍然针对极端工作负载中止。客户机代理 hook 机制已启用。 |

带宽设置定义每个主机传出和传入迁移的最大带宽。

表 2.7. 带宽详细说明

| 策略 | Description |

|---|---|

| auto | 带宽从数据中心主机网络 QoS 中的 Rate Limit [Mbps] 设置中复制。如果尚未定义速率限制,则会计算为发送和接收网络接口最少的链接速度。如果没有设置速率限值,且链路速度不可用,将由发送主机上的本地 VDSM 设置确定。 |

| Hypervisor 默认 | 带宽由发送主机上的本地 VDSM 设置控制。 |

| Custom | 由用户(以 Mbps)定义。这个值被并发迁移数量除以 2 个,以考虑正在进行和传出的迁移。因此,用户定义的带宽必须足够大,以适应所有并发迁移。

例如,如果 |

弹性策略定义了虚拟机在迁移中的优先级。

表 2.8. 弹性策略设置

| 字段 | description/Action |

|---|---|

| 迁移虚拟机 | 按照其定义的优先级迁移所有虚拟机。 |

| 只迁移高度可用的虚拟机 | 仅迁移高度可用的虚拟机,以防止超载其他主机。 |

| 不迁移虚拟机 | 防止虚拟机被迁移。 |

表 2.9. 其他属性设置

| 字段 | description/Action |

|---|---|

| 启用迁移加密 | 允许在迁移过程中对虚拟机进行加密。

|

| 并行迁移 | 允许您指定是否使用多少并行迁移连接。

|

| VM 迁移连接数 | 此设置仅在选择 Custom 时可用。自定义并行迁移的首选数量,2 到 255 之间。 |

2.3.2.5. 调度策略设置说明

通过调度策略,您可以指定可用主机之间虚拟机的使用和分配。定义调度策略,以启用集群中主机之间自动负载平衡。无论调度策略如何,虚拟机都不会在 CPU 过载的主机上启动。默认情况下,如果主机的 CPU 的负载超过 80% 达到 5 分钟,则主机 CPU 被视为过载,但这些值可以使用调度策略来更改。如需更多信息,请参阅管理指南中的调度策略。

表 2.10. 调度策略选项卡属性

| 字段 | description/Action |

|---|---|

| 选择 Policy | 从下拉列表中选择策略。

|

| Properties | 根据所选的策略,会出现以下属性:如果需要,编辑它们:

|

| 调度程序优化 | 为主机权衡/订购优化调度。

|

| 启用信任服务 |

启用与 OpenAttestation 服务器集成。启用此选项之前,使用 |

| 启用 HA 保留 | 启用 Manager 以监控高可用性虚拟机的集群容量。Manager 确保集群中存在适当的容量,以便在现有主机意外发生故障时将其指定为高度可用的虚拟机来迁移。 |

| 序列号策略 | 配置策略,以将序列号分配给集群中的每个新虚拟机:

|

| 自定义序列号 | 指定要应用到集群中的新虚拟机的自定义序列号。 |

当主机的可用内存低于 20% 时,如 mom.Controllers.Balloon - INFO Ballooning guest:half1 from 1096400 to 1991580 的气球命令会记录到 /var/log/vdsm/mom.log。/var/log/vdsm/mom.log 是 Memory Overcommit Manager 日志文件。

2.3.2.6. MaxFreeMemoryForOverUtilized 和 MinFreeMemoryForUnderUtilized 集群调度策略属性

调度程序有一个后台进程,它根据当前的集群调度策略及其参数迁移虚拟机。根据策略中的各种条件及其相对权重,调度程序持续将主机归类为源主机或目标主机,并将个别虚拟机从前迁移到后者。

以下描述解释了 evenly_distributed 和 power_saving 集群调度策略如何与 MaxFreeMemoryForOverUtilized 和 MinFreeMemoryForUnderUtilized 属性进行交互。虽然两个策略都考虑 CPU 和内存负载,但 CPU 负载与 MaxFreeMemoryForOverUtilized 和 MinFreeMemoryForUnderUtilized 属性无关。

如果您将 MaxFreeMemoryForOverUtilized 和 MinFreeMemoryForUnderUtilized 属性定义为 evenly_distributed 策略的一部分:

- 可用内存低于 MaxFreeMemoryForOverUtilized 的可用内存较少,并成为源主机。

- 具有比 MinFreeMemoryForUnderUtilized 可用内存更大且成为目标主机的主机。

- 如果没有定义 MaxFreeMemoryForOverUtilized,调度程序不会根据内存负载迁移虚拟机。(它会根据策略的其他条件(如 CPU 负载)继续迁移虚拟机。)

- 如果没有定义 MinFreeMemoryForUnderUtilized,调度程序会认为所有主机有资格成为目标主机。

如果您将 MaxFreeMemoryForOverUtilized 和 MinFreeMemoryForUnderUtilized 属性定义为 power_saving 策略的一部分:

- 可用内存低于 MaxFreeMemoryForOverUtilized 的可用内存较少,并成为源主机。

- 具有比 MinFreeMemoryForUnderUtilized 可用内存更高且成为源主机的主机。

- 超过 MaxFreeMemoryForOverUtilized 的可用内存数量超过 MaxFreeMemoryForOverUtilized 并不被过度利用,并成为目标主机。

- 低于 MinFreeMemoryForUnderUtilized 的可用内存较少,并未被充分利用且成为目标主机。

- 调度程序更喜欢将虚拟机迁移到既不被过度利用或未被充分利用的主机。如果这些主机没有足够的主机,调度程序可将虚拟机迁移到使用率低的主机。如果不需要充分利用主机来实现这一目的,调度程序就可以关闭它们。

- 如果没有定义 MaxFreeMemoryForOverUtilized,则没有主机被过度使用。因此,只有利用率不足的主机是源主机,目标主机包括集群中的所有主机。

- 如果没有定义 MinFreeMemoryForUnderUtilized,则只有过度利用的主机是源主机,不是被过度利用的主机。

要防止主机过度使用所有物理 CPU,请在 0.1 和 2.9 之间定义虚拟 CPU 到物理 CPU 比率 - VCpuToPhysicalCpuRatio。当设置此参数时,在调度虚拟机时首选使用较低 CPU 的主机。

如果添加虚拟机会导致比例超过限制,则考虑 VCpuToPhysicalCpuRatio 和 CPU 使用率。

在运行的环境中,如果主机 VCpuToPhysicalCpuRatio 超过 2.5,一些虚拟机可能会平衡负载,并移到具有较低 VCpuToPhysicalCpuRatio 的主机。

其他资源

2.3.2.7. 集群控制台设置说明

下表描述了 New Cluster 和 Edit Cluster 窗口中的 Console 选项卡的设置。

表 2.11. 控制台设置

| 字段 | description/Action |

|---|---|

| 为集群定义 SPICE 代理 | 选中此复选框可覆盖全局配置中定义的 SPICE 代理。当用户(例如,通过虚拟机门户进行连接)位于虚拟机监控程序所在的网络之外时,此功能很有用。 |

| 覆盖的 SPICE 代理地址 | SPICE 客户端连接到虚拟机时使用的代理。地址必须采用以下格式: protocol://[host]:[port] |

2.3.2.8. 隔离策略设置说明

下表描述了新集群和编辑集群窗口中的隔离策略选项卡的设置。

表 2.12. 隔离策略设置

| 字段 | description/Action |

|---|---|

| 启用隔离 | 在集群中启用隔离功能。默认情况下启用隔离,但可以根据需要禁用;例如,如果临时网络问题发生或预期,管理员可以禁用隔离,直到诊断或维护活动完成为止。请注意,如果禁用隔离,在不响应的主机中运行的高可用性虚拟机不会在其他位置重启。 |

| 如果主机在存储上有实时租用,则跳过围栏 | 如果选中此复选框,则集群中任何不响应且仍然连接到存储的主机都不会被隔离。 |

| 在集群连接问题中跳过隔离 | 如果选中此复选框,如果遇到连接问题的主机百分比大于或等于定义的 Threshold,则隔离将临时禁用。Threshold 值可以从下拉列表中选择,有效值为 25, 50, 75, 和 100。 |

| 如果 gluster brick 已启动,则跳过隔离 | 只有在启用 Red Hat Gluster Storage 功能时,这个选项才可用。如果选中此复选框,则在 brick 正在运行并且可以从其他同级服务器访问时将跳过隔离。请参阅 Chapter 2。使用隔离策略配置高可用性 和 以及 维护 Red Hat Hyperconverged Infrastructure 中的 Red Hat Gluster 存储附录 A. 隔离策略以获得更多信息。 |

| 如果没有满足 gluster 仲裁,请跳过隔离 | 只有在启用 Red Hat Gluster Storage 功能时,这个选项才可用。如果选中此复选框,在 brick 正在运行并关闭主机时将跳过隔离,则主机将会导致仲裁丢失。请参阅 Chapter 2。使用隔离策略配置高可用性 和 以及 维护 Red Hat Hyperconverged Infrastructure 中的 Red Hat Gluster 存储附录 A. 隔离策略以获得更多信息。 |

2.3.2.9. 为集群中的主机设置负载和电源管理策略

evenly_distributed 和 power_saving 调度策略允许您指定可接受的内存和 CPU 用量值,以及虚拟机必须迁移到主机或从主机中的点。vm_evenly_distributed 调度策略根据虚拟机数量在主机之间平均分配虚拟机。定义调度策略,以启用集群中主机之间自动负载平衡。有关每个调度策略的详细说明,请参阅 集群调度策略设置。

流程

- 点 Compute → Clusters 并选择集群。

- 点 Edit。

- 单击 Scheduling Policy 选项卡。

选择以下策略之一:

- none

vm_evenly_distributed

- 设置必须至少在一台主机上运行的虚拟机数量,以便在 HighVmCount 字段中启用负载平衡。

- 在 MigrationThreshold 字段中定义最高利用率主机上的虚拟机数量和最低利用主机的虚拟机数量之间可接受的最大区别。

- 在 SpmVmGrace 字段中定义要在 SPM 主机上保留虚拟机的插槽数量。

- (可选)在 HeSparesCount 字段中,输入额外自托管引擎节点的数量,以便保留足够的可用内存,以便在 Manager 虚拟机迁移或关闭时启动它。如需更多信息 ,请参阅为自托管引擎配置 Memory Slots Reserved。

evenly_distributed

- 在调度策略在 CpuOverCommitDurationMinutes 字段中采取行动前,设置主机可在定义的使用值外运行 CPU 负载的时间(以分钟为单位)。

- 在 HighUtilization 字段中输入虚拟机开始迁移到其他主机的 CPU 使用率百分比。

- (可选)在 HeSparesCount 字段中,输入额外自托管引擎节点的数量,以便保留足够的可用内存,以便在 Manager 虚拟机迁移或关闭时启动它。如需更多信息 ,请参阅为自托管引擎配置 Memory Slots Reserved。

另外,为了避免主机过度利用所有物理 CPU,请定义虚拟 CPU 到物理 CPU 比例 - VCpuToPhysicalCpuRatio,其值介于 0.1 和 2.9 之间。当设置此参数时,在调度虚拟机时首选使用较低 CPU 的主机。

如果添加虚拟机会导致比例超过限制,则考虑 VCpuToPhysicalCpuRatio 和 CPU 使用率。

在运行的环境中,如果主机 VCpuToPhysicalCpuRatio 超过 2.5,一些虚拟机可能会平衡负载,并移到具有较低 VCpuToPhysicalCpuRatio 的主机。

power_saving

- 在调度策略在 CpuOverCommitDurationMinutes 字段中采取行动前,设置主机可在定义的使用值外运行 CPU 负载的时间(以分钟为单位)。

- 在 LowUtilization 字段中输入主机的 CPU 使用率百分比。

- 在 HighUtilization 字段中输入虚拟机开始迁移到其他主机的 CPU 使用率百分比。

- (可选)在 HeSparesCount 字段中,输入额外自托管引擎节点的数量,以便保留足够的可用内存,以便在 Manager 虚拟机迁移或关闭时启动它。如需更多信息 ,请参阅为自托管引擎配置 Memory Slots Reserved。

选择以下之一作为集群的调度程序优化 :

- 选择 Optimize for Utilization 在调度中包含权重模块,以允许选择最佳。

- 如果请求超过十个,选择 Optimize for Speed 以跳过主机权重。

-

如果您使用 OpenAttestation 服务器验证您的主机,并使用

engine-config工具设置服务器详情,请选择 Enable Trusted Service 复选框。

OpenAttestation 和 Intel Trusted Execution Technology (Intel TXT)不再可用。

- (可选)选择 启用 HA Reservation 复选框,使 Manager 能够监控高可用性虚拟机的集群容量。

(可选)为集群中的虚拟机选择 Serial Number 策略 :

- 点击 OK。

2.3.2.10. 更新集群中的主机上的 MoM 策略

Memory Overcommit Manager 处理主机上的内存 balloon 和 KSM 功能。下一次主机重启后,对这些功能的更改会传递到主机,或处于维护模式后进入 Up 状态。但是,如果需要,您可以对一个主机立刻应用重要的变化,方法是在主机状态为 Up 时同步 MoM 策略。以下过程必须单独在每个主机上执行。

流程

- 单击 Compute → Clusters。

- 点集群名称。这会打开详情视图。

- 单击 Hosts 选项卡,再选择需要更新的 MoM 策略的主机。

- 单击 Sync MoM Policy。

主机上的 MoM 策略可以在不必将主机移至维护模式任何在重新变为 Up 的情况下进行更新。

2.3.2.11. 创建 CPU 配置集

CPU 配置文件定义集群中的一个虚拟机在其上运行的主机上可以访问的最大处理能力,以对该主机可用的总处理能力的百分比表示。CPU 配置集基于数据中心中定义的 CPU 配置集创建,且不会自动应用到集群中的所有虚拟机;它们必须手动分配给各个虚拟机才能使配置文件生效。

此流程假设您已在集群所属的数据中心下定义了一个或多个服务条目的 CPU 质量。

流程

- 单击 Compute → Clusters。

- 点集群名称。这会打开详情视图。

- 点 CPU Profiles 选项卡。

- 单击 New。

- 为 CPU 配置集输入 Name 和 Description。

- 从 QoS 列表中选择要应用到 CPU 配置集的服务质量。

- 点击 OK。

2.3.2.12. 删除 CPU 配置集

从 Red Hat Virtualization 环境中删除现有 CPU 配置集。

流程

- 单击 Compute → Clusters。

- 点集群名称。这会打开详情视图。

- 单击 CPU Profiles 选项卡,再选择要删除的 CPU 配置集。

- 单击 Remove。

- 点击 OK。

如果 CPU 配置集被分配给任何虚拟机,则这些虚拟机会自动 分配默认 CPU 配置集。

2.3.2.13. 导入现有的 Red Hat Gluster Storage 集群

您可以将一个 Red Hat Gluster Storage 集群和属于集群的所有主机都导入到 Red Hat Virtualization Manager。

当您提供集群中任何主机的 IP 地址或主机名等详情时,gluster peer status 命令将通过 SSH 在那个主机上执行,然后显示属于集群一部分的主机列表。您必须手动验证每个主机的指纹,并为它们提供密码。如果集群中的一个主机停机或无法访问,您将无法导入集群。当新导入的主机没有安装 VDSM 时,bootstrap 脚本会在主机上安装所有需要的 VDSM 软件包,并重新启动它们。

流程

- 单击 Compute → Clusters。

- 单击 New。

- 选择集群将属于的数据中心。

- 输入集群的名称和描述。

选中 Enable Gluster Service 复选框,再选择 Import existing gluster configuration 复选框。

只有在选择了 Enable Gluster Service 时,才会显示 Import existing gluster configuration 字段。

在 Hostname 字段中,输入集群中任何服务器的主机名或 IP 地址。

显示主机 SSH 指纹,以确保您使用正确的主机进行连接。如果主机无法访问,或者有网络错误,则在 Fingerprint 字段中会显示一个 Error in fetching fingerprint 错误。

- 输入服务器的密码,然后单击确定。

- 这时将打开 Add Hosts 窗口,并显示属于集群一部分的主机列表。

- 对于每个主机,输入 Name 和 Root Password。

如果要对所有主机使用相同的密码,请选择 Use a Common Password 复选框,以在提供的文本字段中输入密码。

单击 Apply 以设置输入的密码 all hosts。

单击 OK,验证指纹是否有效,并提交您的更改。

引导脚本会在主机上安装所有必需的 VDSM 软件包,并重新启动它们。现在,您已成功将现有的 Red Hat Gluster Storage 集群导入到 Red Hat Virtualization Manager。

2.3.2.14. Add Hosts 窗口中的设置信息

通过 Add Hosts 窗口,您可以指定导入为支持 Gluster 的集群一部分的主机的详细信息。在选择了 New Cluster 窗口中的 Enable Gluster Service 复选框后,将显示此窗口并提供必要的主机详细信息。

表 2.13. 添加 Gluster 主机设置

| 字段 | Description |

|---|---|

| 使用常用密码 | 选择此复选框,对属于一个集群中的所有主机使用相同的密码。在密码字段中输入密码,然后单击应用按钮以在所有主机上设置密码。 |

| Name | 输入主机的名称。 |

| hostname/IP | 此字段会自动填充您在 New Cluster 窗口中提供的主机的完全限定域名或 IP。 |

| Root 密码 | 在此字段中输入密码,为每个主机使用不同的 root 密码。此字段覆盖为集群中的所有主机提供的通用密码。 |

| 指纹 | 此时会显示主机指纹,以确保您使用正确的主机进行连接。此字段会自动填充您在 New Cluster 窗口中提供的主机的指纹。 |

2.3.2.15. 删除集群

在删除前,将所有主机从集群移出。

您无法删除 Default 集群,因为它包含 空白模板。但是,您可以重命名 Default 集群,并将其添加到新数据中心。

流程

- 点 Compute → Clusters 并选择集群。

- 确保集群中没有主机。

- 单击 Remove。

- 点 OK

2.3.2.16. Memory Optimization

要增加主机上的虚拟机数量,您可以使用 内存过量使用,在其中为虚拟机分配的内存超过 RAM,并依赖于交换空间。

但是,内存过量使用有潜在的问题:

- 交换性能 - 交换空间较慢,消耗的 CPU 资源比 RAM 多,会影响虚拟机性能。过量交换会导致 CPU 增大。

- 内存不足 (OOM) killer - 如果主机耗尽交换空间,新进程无法启动,内核的 OOM 终止程序守护进程开始关闭活跃的进程,如虚拟机客户机。

为了帮助克服这些不足,您可以执行以下操作:

- 使用内存优化设置和内存过量使用管理器 (MoM) 限制内存过量使用。

- 使交换空间足够大,以适应虚拟内存的最大潜力需求,并且剩余安全利润。

- 通过启用内存气球和内核同页合并 (KSM) 减少虚拟内存大小。

2.3.2.17. 内存优化和内存过量使用

您可以通过选择其中一个内存优化设置来限制内存过量使用:None (0%), 150%, or 200%.

每个设置代表 RAM 百分比。例如,有一个具有 64 GB RAM 的主机,选择 150% 表示您可以增加 32 GB 的内存,总内存为 96 GB。如果主机使用总共 4 GB 的 4 GB,则剩余的 92 GB 可用。您可以将其大部分分配给虚拟机(System 标签页中的 Memory Size),但应该考虑保留一些空间以减少出问题的可能。

对虚拟内存的需求激增可能会影响M、内存膨胀和 KSM 重新定义虚拟内存的时间。要减少这个影响,请选择适合您运行的应用程序和工作负载的限制:

- 对于内存需求递增的工作负载,请选择较高的百分比,如 200% 或 150%。

- 对于更关键的应用程序或工作负载在内存需求增加时增加,请选择 150% 或 None (0%)百分比。选择 None 有助于防止内存过量使用,但允许 MoM、内存 balloon 设备和 KSM 继续优化虚拟内存。

在将配置部署到生产环境之前,请始终通过对各种条件进行测试来测试您的 内存优化 设置。

要配置 Memory Optimization 设置,点 New Cluster 或 Edit Cluster 窗口中的 Optimization 选项卡。请参阅 集群优化设置说明。

其他评论:

- Host Statistics 视图显示 有用的历史信息,以调整过量使用比率。

- 实际可用的内存无法实时确定,因为 KSM 和内存膨胀更改达到的内存大小。

- 当虚拟机达到虚拟内存限制时,新的应用程序无法启动。

- 当您计划在主机上运行的虚拟机数量时,请使用最大虚拟内存(物理内存大小和 内存优化 设置)作为起点。不要因内存优化而实现的较小的虚拟内存中因素,如内存膨胀和 KSM。

2.3.2.18. swap Space 和 Memory Overcommitment

在应用这些建议时,请按照指导将交换空间大小调整为"最后工作量内存"以获得最糟糕的情况。使用物理内存大小和 内存优化 设置作为估算总虚拟内存大小的基础。MoM、内存膨胀和 KSM 禁止虚拟内存的优化减少。

为帮助防止 OOM 条件,使交换空间足够大,以处理最糟糕的情况,并且仍然具有安全利润。在部署到生产环境之前,始终在各种条件下测试您的配置。

2.3.2.19. Memory Overcommit Manager (MoM)

Memory Overcommit Manager (MoM) 分为两个事务:

- 它通过将 Memory Optimization 设置应用到集群中的主机来限制内存过量使用,如上一节中所述。

- 它通过管理 内存 ballooning 和 KSM 来优化内存,具体如以下部分所述。

您不需要启用或禁用 MoM。

当主机的可用内存低于 20% 时,像 mom.Controllers.Balloon - INFO Ballooning guest:half1 from 1096400 to 1991580 的气球命令会记录到 Memory Overcommit Manager 日志文件(/var/log/vdsm/mom.log)。

2.3.2.20. 内存膨胀

虚拟机从您分配给它们的完整虚拟内存数量开始。由于虚拟内存使用量超过 RAM,因此主机需要更多 swap 空间。如果启用,内存膨胀 可让虚拟机提供该内存中未使用的部分。空闲的内存可以被主机上的其他进程和虚拟机重复使用。减少内存占用率会降低交换的可能性,并提高性能。

virtio-balloon 软件包提供了内存膨胀设备和驱动程序,作为可加载的内核模块(LKM)。默认情况下,它被配置为自动加载。将模块添加到 denyist 或卸载时禁用 ballooning。

内存膨胀设备不直接协调;它们依赖于主机的 Memory Overcommit Manager (MoM)流程来持续监控每个虚拟机的需求,并指示 balloon 设备增加或降低虚拟内存。

性能考虑:

- 对于需要持续高性能和低延迟的工作负载,红帽不推荐使用内存膨胀和过量使用。请参阅配置高性能虚拟机、模板和池。

- 当增加虚拟机密度(经济)比性能更重要时,使用内存膨胀。

- 内存膨胀不会影响 CPU 使用率。(KSM 消耗一些 CPU 资源,但消耗会保持在压力下的一致性。)

要启用内存膨胀,请单击 New Cluster 或 Edit Cluster 窗口中的 Optimization 选项卡。然后选择 Enable Memory Balloon Optimization 复选框。这个设置可在此集群中运行的虚拟机上启用内存使用过量。选择此复选框后,M 会尽可能启动膨胀,但会限制每个虚拟机的保证内存大小。请参阅 集群优化设置说明。

此集群中的每个主机在状态更改为开机时会收到 balloon 策略更新。如果需要,您可以手动更新主机上的 balloon 策略,而无需更改状态。请参阅在集群的主机上更新 MoM 策略。

2.3.2.21. 内核同页合并(KSM)

当虚拟机运行时,它通常会为常见库和高使用数据等项目创建重复的内存页面。另外,运行类似客户机操作系统和应用程序的虚拟机会在虚拟内存中生成重复的内存页面。

启用后,内核同页合并 (KSM)检查主机上的虚拟内存,消除了重复内存页面,并在多个应用程序和虚拟机间共享剩余的内存页面。这些共享内存页面标记为写时复制;如果虚拟机需要向该页面写入更改,它会首先进行复制,然后再将其修改写入到该副本。

启用 KSM 时,M 会管理 KSM。您不需要手动配置或控制 KSM。

KSM 通过两种方式增加虚拟内存性能:由于更频繁地使用共享内存页面,因此主机更有可能将其存储在缓存中或主内存中,从而提高了内存访问速度。另外,有内存过量使用,KSM 会减少虚拟内存空间,从而减少交换性能的可能性。

KSM 消耗的 CPU 资源超过内存膨胀。在压力下,CPU KSM 消耗量保持一致性。在主机上运行相同的虚拟机和应用程序,与运行相同虚拟机和应用程序相比,KSM 有机会合并内存页面。如果您运行大多数不同的虚拟机和应用程序,使用 KSM 的 CPU 成本可能会降低其好处。

性能考虑:

- 在 KSM 守护进程合并大量内存后,内核内存核算统计最终可能会相互冲突。如果您的系统有大量可用内存,可以通过禁用 KSM 来提高性能。

- 对于需要持续高性能和低延迟的工作负载,红帽不推荐使用 KSM 和过量使用。请参阅配置高性能虚拟机、模板和池。

- 在增加虚拟机密度(经济)时,使用 KSM 比性能更重要。

要启用 KSM,请单击 New Cluster 或 Edit Cluster 窗口中的 Optimization 选项卡。然后选择" 启用 KSM "复选框。此设置可让 MoM 在需要时运行 KSM,并在生成内存时可以降低其 CPU 的成本。请参阅 集群优化设置说明。

2.3.2.22. UEFI 和 Q35 芯片组

Intel Q35 芯片组(新虚拟机的默认芯片组)包括支持统一可扩展固件接口(UEFI),取代传统的 BIOS。

或者,您可以将虚拟机或集群配置为使用旧的 Intel i440fx 芯片组,该芯片组不支持 UEFI。

UEFI 与旧的 BIOS 相比提供了几个优势,包括:

- 现代引导装载程序

- SecureBoot,用于验证引导装载程序的数字签名

- GUID 分区表(GPT),它启用大于 2 TB 的磁盘

要在虚拟机上使用 UEFI,您必须将虚拟机的集群配置为 4.4 或更高版本。然后,您可以为任何现有虚拟机设置 UEFI,或者设置为集群中新虚拟机的默认 BIOS 类型。可用的选项如下:

表 2.14. 可用的 BIOS 类型

| BIOS 类型 | Description |

|---|---|

| 带有传统 BIOS 的 Q35 Chipset | 没有 UEFI 的旧 BIOS (用于兼容版本 4.4 的集群的默认设置) |

| 使用 UEFI BIOS 的 Q35 Chipset | 使用 UEFI 的 BIOS |

| 带有 SecureBoot 的 Q35 Chipset | 带有 SecureBoot 的 UEFI,它验证引导装载程序的数字签名 |

| legacy | 带有传统 BIOS 的 i440fx 芯片组 |

在安装操作系统前设置 BIOS 类型

在安装操作系统前,您可以将虚拟机配置为使用 Q35 芯片组和 UEFI。在安装操作系统后,不支持将虚拟机从旧的 BIOS 转换为 UEFI。

2.3.2.23. 配置集群以使用 Q35 Chipset 和 UEFI

将集群升级到 Red Hat Virtualization 4.4 后,集群中的所有虚拟机都运行 4.4 版本 VDSM。您可以配置集群的默认 BIOS 类型,该类型决定了集群中您创建的任何新虚拟机的默认 BIOS 类型。如果需要,您可以在创建虚拟机时指定不同的 BIOS 类型来覆盖集群的默认 BIOS 类型。

流程

- 在虚拟机门户或管理门户中,点 Compute → Clusters。

- 选择一个集群并点 Edit。

- 点 General。

点 BIOS 类型下拉菜单在集群中的新虚拟机定义默认 BIOS 类型,并选择以下任一操作:

- legacy

- 带有传统 BIOS 的 Q35 Chipset

- 使用 UEFI BIOS 的 Q35 Chipset

- 带有 SecureBoot 的 Q35 Chipset

- 从 兼容性版本 下拉菜单中选择 4.4。Manager 检查所有正在运行的主机是否都与 4.4 兼容,如果兼容,则 Manager 使用 4.4 功能。

- 如果集群中的任何现有虚拟机应该使用新的 BIOS 类型,请将它们配置为这样做。现在,集群中配置为使用 BIOS 类型 Cluster default 的新虚拟机现在使用您选择的 BIOS 类型。如需更多信息,请参阅配置虚拟机以使用 Q35 Chipset 和 UEFI。

由于只能在安装操作系统前更改 BIOS 类型,所以对于配置为使用 BIOS 类型 Cluster default 的任何现有虚拟机,请将 BIOS 类型更改为之前的默认集群 BIOS 类型。否则,虚拟机可能无法引导。或者,您可以重新安装虚拟机的操作系统。

2.3.2.24. 配置虚拟机以使用 Q35 Chipset 和 UEFI

在安装操作系统前,您可以将虚拟机配置为使用 Q35 芯片组和 UEFI。将虚拟机从旧的 BIOS 转换为 UEFI,或从 UEFI 转换为旧 BIOS 可能会阻止虚拟机引导。如果更改现有虚拟机的 BIOS 类型,请重新安装操作系统。

如果虚拟机的 BIOS 类型设为 Cluster default,更改集群的 BIOS 类型会更改虚拟机的 BIOS 类型。如果虚拟机安装了操作系统,更改集群 BIOS 类型可能会导致引导虚拟机失败。

流程

配置虚拟机以使用 Q35 芯片组和 UEFI:

- 在虚拟机门户或管理门户中点 Compute → Virtual Machines。

- 选择虚拟机并点 Edit。

- 在 General 选项卡中,单击 Show Advanced Options。

- 单击 System → Advanced Parameters。

从 BIOS 类型下拉菜单中选择 以下内容之一:

- 集群默认

- 带有传统 BIOS 的 Q35 Chipset

- 使用 UEFI BIOS 的 Q35 Chipset

- 带有 SecureBoot 的 Q35 Chipset

- 点击 OK。

- 在 Virtual Machine Portal 或 Administration Portal 中关闭虚拟机。下次启动虚拟机时,它将使用您选择的新 BIOS 类型运行。

2.3.2.25. 更改集群兼容性版本

Red Hat Virtualization 集群有一个兼容版本。集群兼容性版本表示集群中所有主机支持的 Red Hat Virtualization 的功能。集群兼容性根据集群中功能最低的主机操作系统版本来设置。

先决条件

- 要更改集群兼容性级别,您必须首先将集群中的所有主机更新为支持您需要的兼容性级别。检查主机旁边是否存在指示有可用的更新的图标。

限制

在将集群兼容性级别升级到 4.6 后,virtio NIC 会作为不同的设备枚举。因此,可能需要重新配置 NIC。红帽建议您在升级集群前测试虚拟机,方法是在虚拟机上将集群兼容性级别设置为 4.6 并验证网络连接。

如果虚拟机的网络连接失败,在升级集群前,使用与当前模拟机器匹配的自定义模拟机器配置虚拟机,例如 pc-q35-rhel8.3.0 适用于 4.5 兼容性版本。

流程

- 在管理门户中,点 Compute → Clusters。

- 选择要更改的集群并点击 Edit。

- 在 General 选项卡中,将 Compatibility Version 更改为所需的值。

- 点击 确定。此时会打开 Change Cluster Compatibility Version 确认对话框。

- 点 OK 确认。

错误消息可能会警告某些虚拟机和模板配置不正确。要修复此错误,请手动编辑每个虚拟机。Edit Virtual Machine 窗口提供了额外的验证和警告来显示正确的内容。有时问题会自动解决,虚拟机的配置只需要再次保存。编辑完每个虚拟机后,您将能够更改集群兼容性版本。

在更新了集群兼容性版本后,您必须通过从管理门户重启或使用 REST API 来更新所有正在运行的或暂停虚拟机的集群兼容性版本,或使用客户端操作系统中的 REST API 更新它们。需要重启的虚拟机将标记为待处理更改图标(

)。您无法更改处于预览的虚拟机快照的集群兼容性版本。您必须首先提交或撤销预览。

)。您无法更改处于预览的虚拟机快照的集群兼容性版本。您必须首先提交或撤销预览。

在自托管引擎环境中,管理器虚拟机不需要重新启动。

虽然您可以在以后方便的时候重新启动虚拟机,但强烈建议您立即重新启动,以便虚拟机使用最新的配置。旧配置没有更新运行的虚拟机,在重启前,如果对虚拟机进行其他更改,新的配置会被覆盖。

在更新了数据中心中所有集群和虚拟机的兼容性版本后,您可以更改数据中心本身的兼容性版本。

2.4. 逻辑网络

2.4.1. 逻辑网络任务

2.4.1.1. 执行网络任务

Network → Networks 为用户提供一个中央位置,供用户执行逻辑网络相关的操作,并根据每个网络的属性或与其他资源关联搜索逻辑网络。通过新建、编辑和删除按钮,您可以在数据中心内创建、更改 的属性和删除逻辑网络。

点击每个网络名称,并使用详情视图中的标签页执行功能,包括:

- 将网络附加到集群和主机

- 从虚拟机和模板中删除网络接口

- 为用户添加或删除权限以访问和管理网络

这些功能也可以通过每个单独的资源访问。

如果有任何主机正在运行,则不要更改数据中心或集群中的网络,因为这可能导致主机变得不可访问。

如果您计划使用 Red Hat Virtualization 节点提供任何服务,请记住,如果 Red Hat Virtualization 环境停止操作,该服务将停止。

这适用于所有服务,但您应该特别意识到在 Red Hat Virtualization 上运行以下内容:

- 目录服务

- DNS

- 存储

2.4.1.2. 在数据中心或集群中创建新的逻辑网络

创建逻辑网络并在数据中心或数据中心内定义其使用。

流程

- 点 Compute → Data Centers 或 Compute → Clusters。

- 点数据中心或集群名称。Details 视图将打开。

- 单击 逻辑网络 选项卡。

打开 New Logical Network 窗口:

- 从数据中心详情视图中,单击 New。

- 在集群详情视图中点 Add Network。

- 输入逻辑网络的 Name、Description 和注释。

- 可选: 启用 VLAN 标记。

- 可选:禁用 VM Network。

可选: 选择 Create on external provider 复选框。这可禁用网络标签和 VM 网络。有关详细信息,请参阅 外部提供程序。

- 选择 External Provider。External Provider 列表不包含处于只读模式下的外部提供程序。

- 要创建内部隔离网络,请在 External Provider 列表上选择 ovirt-provider-ovn ,并保持连接到物理网络 已清除。

- 输入新标签,或者在 Network Label 文本字段中为逻辑网络选择现有标签。

对于 MTU,可选择 Default (1500),或者选择 Custom 并指定自定义值。

重要在外部提供程序上创建网络后,您无法更改网络的 MTU 设置。

重要如果更改网络的 MTU 设置,您必须将此更改传播到网络中的正在运行的虚拟机:Hot unplug 和 replug each virtual machine 的 vNIC(应该应用 MTU 设置),或重启虚拟机。否则,当虚拟机迁移到另一台主机时,这些接口会失败。如需更多信息,请参阅 网络 MTU 更改后,一些虚拟机和网桥有旧的 MTU,查看数据包丢弃 和 BZ#1766414。

- 如果您从 External Provider 下拉列表中选择了 ovirt-provider-ovn,请定义网络是否应该实施安全组。有关详细信息,请参阅 逻辑网络常规设置说明。

- 在 Cluster 选项卡中,选择将网络分配到的集群。您还可以指定逻辑网络是否是必需的网络。

- 如果选中 Create on external provider 复选框,则会看到 Subnet 选项卡。从子网选项卡中,选择创建子网并输入名称、CIDR 和网关地址,然后为逻辑网络提供的子网选择 IP 版本。您还可以根据需要添加 DNS 服务器。

- 在 vNIC Profiles 选项卡中,根据需要将 vNIC 配置集添加到逻辑网络中。

- 点击 OK。

如果您为逻辑网络输入标签,则会自动添加到具有该标签的所有主机网络接口。

当创建新逻辑网络或更改用作显示网络的现有逻辑网络时,必须在网络可用或应用更改前重启使用该网络的任何正在运行的虚拟机。

2.4.1.3. 编辑逻辑网络

如果没有与主机上的网络配置同步,则无法编辑或移动逻辑网络。请参阅 编辑主机网络接口,并在如何同步您的网络时将逻辑网络分配给主机。

当更改用作显示网络的现有逻辑网络的虚拟机网络属性时,无法在已在运行的虚拟机的主机上启动新的虚拟机。只有更改 VM Network 属性后没有运行虚拟机的主机才能启动新虚拟机。

流程

- 单击 Compute → Data Centers。

- 点数据中心名称。这会打开详情视图。

- 单击 Logical Networks 选项卡,再选择逻辑网络。

- 点 Edit。

编辑必要的设置。

注意您可以编辑新网络或现有网络的名称,但默认网络除外,而无需停止虚拟机。

- 点击 OK。

多主机网络配置会自动将更新的网络设置应用到分配到网络的所有主机。只有在使用网络的虚拟机停机时,才能应用更改。您不能重命名已在主机上配置的逻辑网络。在使用该网络的虚拟机或模板运行时,您无法禁用 VM Network 选项。

2.4.1.4. 删除逻辑网络

您可以从 Network → Networks 或 Compute → Data Centers 中删除一个逻辑网络。以下步骤演示了如何删除与数据中心关联的逻辑网络。对于 Red Hat Virtualization 环境,您必须至少有一个逻辑网络用作 ovirtmgmt 管理网络。

流程

- 单击 Compute → Data Centers。

- 点数据中心的名称。这会打开详情视图。

- 点逻辑网络 选项卡,以列出数据中心的逻辑网络。

- 选择逻辑网络,然后单击删除。

- (可选) 从提供程序选择 Remove external network (s) 和复选框,以便在外部提供者提供网络时从 Manager 中删除逻辑网络或从外部供应商中删除。如果外部供应商处于只读模式,则勾选框将灰显。

- 点击 OK。

逻辑网络已从 Manager 中删除,且不再可用。

2.4.1.5. 将非管理逻辑网络配置为默认路由

集群中主机使用的默认路由通过管理网络(ovirtmgmt)。以下流程提供将非管理逻辑网络配置为默认路由的说明。

先决条件:

-

如果使用

default_route自定义属性,则需要从所有附加的主机清除自定义属性,然后按照以下步骤操作。

配置默认路由角色

- 单击 Network → Networks。

- 点非管理逻辑网络的名称,将其配置为默认路由,以访问其详细信息。

- 点 Clusters 选项卡。

- 单击 Manage Network。这将打开 Manage Network 窗口。

- 为适当的集群选择默认路由复选框。

- 点击 OK。

当网络附加到主机时,将在您选择的网络上设置主机的默认路由。建议您在将任何主机添加到集群中前配置默认路由角色。如果集群已经包含主机,则它们可能会不同步,直到您将更改同步至它们。

IPv6 的重要限制

- 对于 IPv6,Red Hat Virtualization 仅支持静态寻址。

- 如果两个网络共享一个网关(在同一子网中),您可以将默认路由角色从管理网络(ovirtmgmt)移到另一个逻辑网络。

- 如果主机和管理器不在同一子网中,则管理器将断开与主机的连接,因为删除了 IPv6 网关。

- 将默认路由角色移到非管理网络中,会从网络接口中删除 IPv6 网关,并生成警报:"On cluster clustername the 'Default Route Role' network is no longer network ovirtmgmt.IPv6 网关正在从此网络中删除"。

2.4.1.6. 在主机上添加静态路由

您可以使用 nmstate 为主机添加静态路由。此方法要求您直接配置主机,而无需使用 Red Hat Virtualization Manager。

只要相关的路由网桥、接口或绑定存在并且具有 IP 地址,您添加的 static-route 就会保留。否则,系统会移除静态路由。

除了在主机上添加或删除静态路由外,请务必使用 RHV Manager 在集群中配置主机网络设置。详情请查看 Network Manager Stateful Configuration (nmstate)。

自定义 static-route 会保留,只要其 interface/bond 存在且具有 IP 地址。否则,它将被删除。

因此,VM 网络的行为与非VM 网络不同:

- VM 网络基于网桥。将网络从一个接口/bond 移动到另一个接口不会影响虚拟机网络上的路由。

- 非 VM 网络基于接口。将网络从一个接口/bond 移到另一个接口,会删除与 Non-VM 网络相关的路由。

前提条件

这个过程需要 nmstate,这只在您的环境使用时可用:

- Red Hat Virtualization Manager 版本 4.4

- 基于 Red Hat Enterprise Linux 8 的 Red Hat Enterprise Linux 主机和 Red Hat Virtualization 主机

流程

- 连接到您要配置的主机。

在主机上,创建一个

static_route.yml文件,其中包含以下示例内容:routes: config: - destination: 192.168.123.0/24 next-hop-address: 192.168.178.1 next-hop-interface: eth1- 将示例值替换为您的网络实际值。

要将流量路由到添加的二级网络,请使用

next-hop-interface指定接口或网络名称。-

要使用非虚拟机网络,请指定

eth1等接口。 -

要使用虚拟机网络,请指定同时是网桥名称(如

net1)的网络名称。

-

要使用非虚拟机网络,请指定

运行这个命令:

$ nmstatectl set static_route.yml

验证步骤

使用您在

static_route.yml中设置的目的地参数值运行 IP route 命令ip route。这应该会显示所需的路由。例如,运行以下命令:$ ip route | grep 192.168.123.0`

2.4.1.7. 删除主机上的静态路由

您可以使用 nmstate 从主机中删除静态路由。此方法要求您直接配置主机,而无需使用 Red Hat Virtualization Manager。

除了在主机上添加或删除静态路由外,请务必使用 RHV Manager 在集群中配置主机网络设置。详情请查看 Network Manager Stateful Configuration (nmstate)。

自定义 static-route 会保留,只要其 interface/bond 存在且具有 IP 地址。否则,它将被删除。

因此,VM 网络的行为与非VM 网络不同:

- VM 网络基于网桥。将网络从一个接口/bond 移动到另一个接口不会影响虚拟机网络上的路由。

- 非 VM 网络基于接口。将网络从一个接口/bond 移到另一个接口,会删除与 Non-VM 网络相关的路由。

前提条件

这个过程需要 nmstate,这只在您的环境使用时可用:

- Red Hat Virtualization Manager 版本 4.4

- 基于 Red Hat Enterprise Linux 8 的 Red Hat Enterprise Linux 主机和 Red Hat Virtualization 主机

流程

- 连接到您要重新配置的主机。

-

在主机上,编辑

static_route.yml文件。 -

插入行

state: absent,如下例所示。 在

interfaces: []的括号间添加next-hop-interface。其结果应当类似于此处显示的示例。routes: config: - destination: 192.168.123.0/24 next-hop-address: 192.168.178. next-hop-interface: eth1 state: absent interfaces: [{“name”: eth1}]运行这个命令:

$ nmstatectl set static_route.yml

验证步骤

使用您在

static_route.yml中设置的目的地参数值运行 IP route 命令ip route。这应该不再显示所需的路由。例如,运行以下命令:$ ip route | grep 192.168.123.0`

2.4.1.8. 查看或编辑逻辑网络的网关

用户可以为逻辑网络定义网关以及 IP 地址和子网掩码。当主机上存在多个网络,并且流量应通过指定的网络而不是默认网关进行路由时需要这样做。

如果主机上存在多个网络,且未定义网关,返回的流量将通过默认网关路由,该网关可能无法到达预期的目的地。这会导致用户无法 ping 主机。

当接口上线或停机时,Red Hat Virtualization 会自动处理多个网关。

流程

- 单击 Compute → Hosts。

- 单击主机的名称。这会打开详情视图。

- 单击 Network Interfaces 选项卡,以列出附加到主机的网络接口,以及它们的配置。

- 单击 Setup Host Networks。

- 将光标悬停在分配的逻辑网络上,然后点铅笔图标。此时将打开 Edit Management Network 窗口。

Edit Management Network 窗口显示网络名称、引导协议以及 IP、子网掩码和网关地址。可以通过选择 静态 引导协议来手动编辑地址信息。

2.4.1.9. 逻辑网络常规设置说明

下表描述了新逻辑网络和编辑逻辑网络窗口的常规选项卡的设置。

表 2.15. New Logical Network 和 Edit Logical Network 设置

| 字段名称 | Description |

|---|---|

| Name | 逻辑网络的名称。此文本字段必须是唯一名称,包含大写字母和小写字母、数字、连字符和下划线的任意组合。 请注意,尽管逻辑网络的名称可能超过 15 个字符,并且可以包含非 ASCII 字符,但 on-host 标识符(vdsm_name)将与您定义的名称不同。有关显示这些名称 映射的信息,请参阅将 VDSM 名称映射到逻辑网络 名称。 |

| Description | 逻辑网络的描述。此文本字段具有 40 个字符的限值。 |

| 注释 | 用于添加与逻辑网络相关的纯文本可读注释的字段。 |

| 在外部供应商上创建 | 允许您将逻辑网络创建到作为外部提供者添加到 Manager 的 OpenStack 网络实例中。 external Provider - 允许您选择要在其上创建逻辑网络的外部供应商。 |

| 启用 VLAN 标记 | VLAN 标记是一种安全功能,可为逻辑网络上传输的所有网络流量具有特殊特征。标记为 VLAN 的流量无法通过没有该特征的接口读取。在逻辑网络上使用 VLAN 还支持单个网络接口与多个网络接口关联,不同的是 VLAN 标记的逻辑网络。如果启用了 VLAN 标记,在文本条目字段中输入数字值。 |

| VM Network | 如果只有虚拟机使用此网络,则选择这个选项。如果网络用于不涉及虚拟机(如存储通讯)的流量,请不要选中此复选框。 |