director 的安装和使用

使用 Red Hat OpenStack Platform director 创建 OpenStack 云环境

OpenStack Documentation Team

rhos-docs@redhat.com摘要

第 1 章 简介

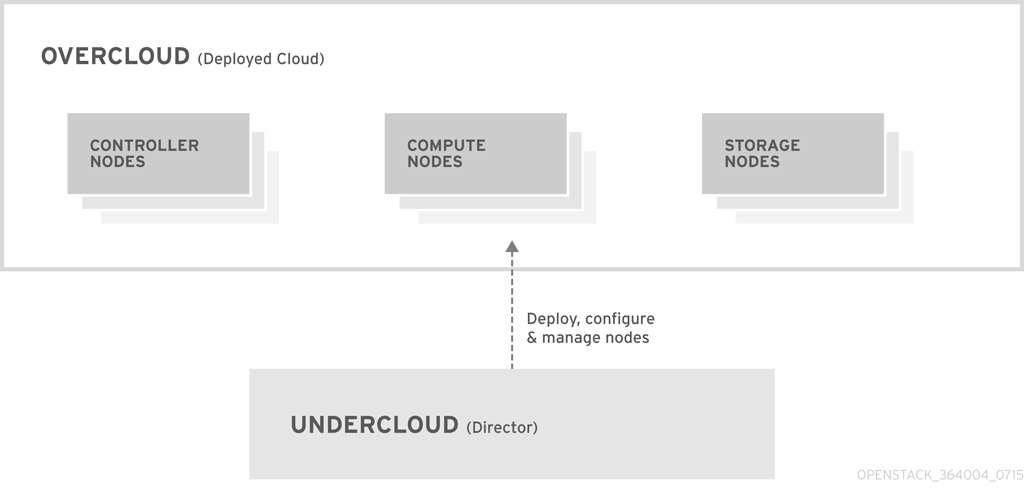

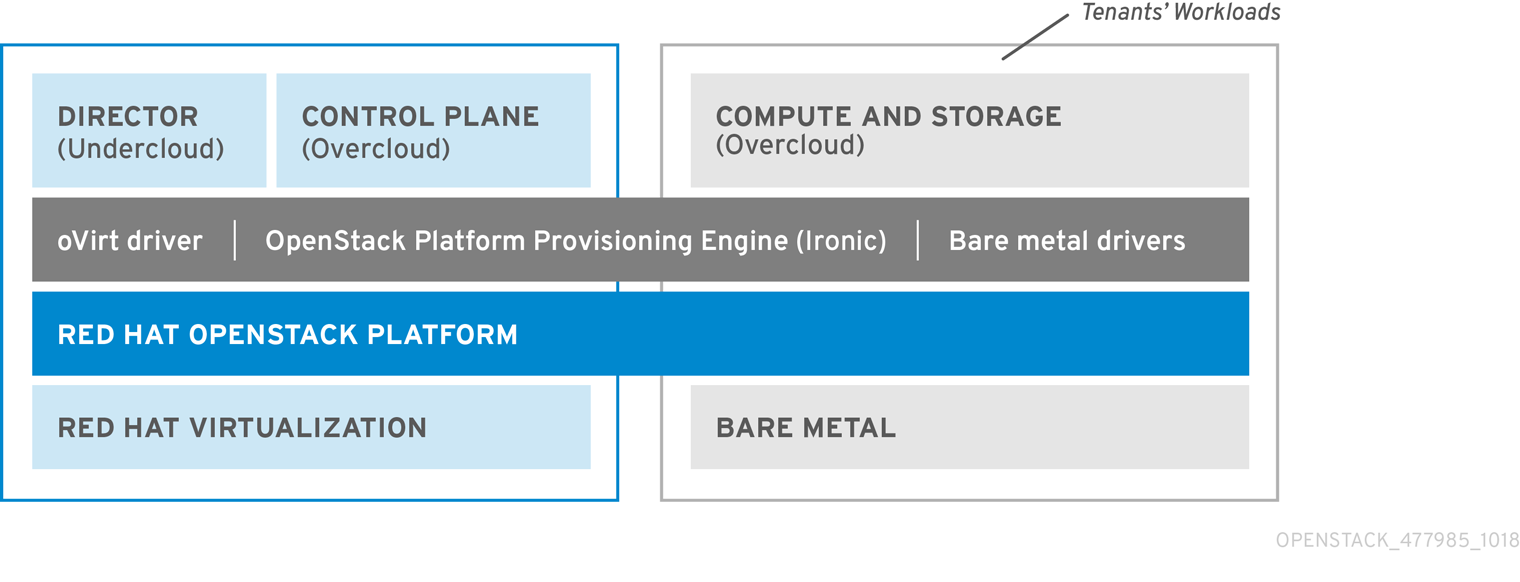

Red Hat OpenStack Platform director 是一个安装和管理完整的 OpenStack 环境的工具组,它主要基于 OpenStack 项目 - TripleO("OpenStack-On-OpenStack" 的缩写)。director 主要基于 OpenStack project TripleO(“OpenStack-On-OpenStack” 的缩写)。此项目包含可用于安装全面运行的 OpenStack 环境的 OpenStack 组件。其中包括置备并控制裸机系统用作 OpenStack 节点的 OpenStack 组件。这为安装精益可靠的完整 Red Hat OpenStack Platform 环境提供了一种简单方法。

Red Hat OpenStack Platform director 使用两个主要概念:undercloud 和 overcloud。undercloud 用来安装并配置 overcloud。下面几节概述了这两个概念。

1.1. undercloud

undercloud 是包含 OpenStack 平台 director 工具组的主要管理节点,它是由单一系统组成的 OpenStack 安装,并包括了置备和管理 OpenStack 环境 (overcloud) 所需的组件。它是一个单一系统的 OpenStack 安装,包括置备和管理组成 OpenStack 环境 (overcloud) 的 OpenStack 节点的组件。组成 undercloud 的组件具有多个功能:

- 环境规划

- undercloud 包括用户用于创建和分配某些节点规则的规划功能。undercloud 包括一组默认节点:计算(Compute)、控制器(Controller)和各种存储角色。您也可以设计自定义角色。此外,您还可以选择每个节点角色包括哪些 OpenStack Platform 服务。这提供了对新节点建模,或把特定组件隔离在其自己的主机中的方法。

- 裸机系统控制

- undercloud 使用每个节点的带外管理接口(通常是智能平台管理接口 (IPMI))进行电源管理控制,使用基于 PXE 的服务发现硬件属性并在每个节点上安装 OpenStack。您可以使用此功能将裸机系统置备为 OpenStack 节点。有关电源管理驱动程序的完整列表,请参阅 附录 A, 电源管理驱动。

- 编配

- undercloud 包含一组 YAML 模板,这些模板代表您环境中的一系列计划。undercloud 导入这些计划,并根据其中的指示创建所需的 OpenStack 环境。这些计划还可以包括 hook。通过使用 hook,可以在环境创建过程中的特定点上融入您自己的自定义设置。

- undercloud 组件

undercloud 使用 OpenStack 组件作为它的基本工具组。每个组件都在 undercloud 中的一个独立容器内运行:

- OpenStack Identity (keystone) - 提供 director 组件的验证和授权功能。

- OpenStack Bare Metal (ironic) 和 OpenStack Compute (nova) - 管理裸机节点。

- OpenStack Networking (neutron) 和 Open vSwitch - 控制裸机节点的网络。

- OpenStack Image Service (glance) - 存储 director 写入裸机的镜像。

- OpenStack Orchestration (heat) 和 Puppet - 提供对节点的编配功能,并在 director 把 overcloud 镜像写入到磁盘后配置节点。

OpenStack Telemetry(ceilometer) - 监控并采集数据。这还包括:

- OpenStack Telemetry Metrics(gnocchi) - 为 metrics 提供一个时间序列数据库。

- OpenStack Telemetry Alarming(aodh) - 为监控提供一个警告组件。

- OpenStack Telemetry Event Storage(panko)- 为监控提供事件存储。

- OpenStack Workflow Service(mistral) - 为特定 director 操作(如导入和部署计划)提供一组工作流程。

- OpenStack Messaging Service(zaqar) - 为 OpenStack Workflow Service 提供一个消息服务。

OpenStack Object Storage(swift) - 为不同的 OpenStack 平台组件提供对象存储,包括:

- 为 OpenStack Image Service 提供镜像存储

- 为 OpenStack Bare Metal 提供内省数据

- 为 OpenStack Workflow Service 提供部署计划

1.2. overcloud

overcloud 是 undercloud 创建的 Red Hat OpenStack Platform 环境。overcloud 包括多个具有不同角色的节点,这些角色是基于您要创建的 OpenStack Platform 环境定义的。undercloud 包括一组默认的 overcloud 节点角色:

- Controller

Controller 节点为 OpenStack 环境提供管理、网络和高可用性功能。建议的 OpenStack 环境是在一个高可用性集群中包含三个 Controller 节点。

一个默认 Controller(控制器)节点包括以下组件:

- OpenStack Dashboard (horizon)

- OpenStack Identity (keystone)

- OpenStack Compute (nova) API

- OpenStack Networking (neutron)

- OpenStack Image Service (glance)

- OpenStack Block Storage (cinder)

- OpenStack Object Storage (swift)

- OpenStack Orchestration (heat)

- OpenStack Telemetry Metrics (gnocchi)

- OpenStack Telemetry Alarming (aodh)

- OpenStack Telemetry Event Storage (panko)

- OpenStack Clustering (sahara)

- OpenStack Shared File Systems(manila)

- OpenStack Bare Metal(ironic)

- MariaDB

- Open vSwitch

- 高可用性服务的 Pacemaker 和 Galera。

- 计算

Compute 节点为 OpenStack 环境提供计算资源。随着时间的推移,可以通过添加更多节点来扩展您的环境。一个默认 Compute (计算)节点包括以下组件:

- OpenStack Compute (nova)

- KVM/QEMU

- OpenStack Telemetry (ceilometer) 代理

- Open vSwitch

- 存储

为 OpenStack 环境提供存储的存储节点。以下列表包含有关 Red Hat OpenStack Platform 中存储节点的各种类型的信息:

- Ceph Storage 节点 - 用来组成存储集群,每个节点包括一个 Ceph Object Storage Daemon(OSD)。每个节点包含一个 Ceph Object Storage Daemon (OSD)。此外,当您部署 Ceph Storage 节点作为环境一部分时,director 将 Ceph Monitor 安装到 Controller 节点上。

Block storage (cinder) - 用作高可用性 Controller 节点的外部块存储。这类节点包括以下组件:

- OpenStack Block Storage (cinder) 卷

- OpenStack Telemetry 代理

- Open vSwitch.

Object Storage (swift) - 这些节点为 OpenStack Swift 提供了一个外部存储层。Controller 节点通过 Swift 代理访问对象存储节点。对象存储节点包含以下组件:

- OpenStack Object Storage (swift) 存储

- OpenStack Telemetry 代理

- Open vSwitch.

1.3. 高可用性

Red Hat OpenStack Platform director 使用 Controller 节点集群向 OpenStack Platform 环境提供高可用服务。对于每个服务,director 在所有 Controller 节点上安装相同的组件,并作为单个服务一起管理这些 Controller 节点。在单个 Controller 节点上出现运行故障时,这种集群配置提供回退(fallback)机制。这可以使 OpenStack 用户实现某种程度的不中断运行。

OpenStack Platform director 使用以下软件来管理 Controller 节点上的组件:

- Pacemaker - Pacemaker 是集群资源管理器。Pacemaker 管理和监控集群中所有节点上的 OpenStack 组件的可用性。

- HA Proxy(HA 代理) - 为集群提供负载平衡和代理服务。

- Galera - 在集群中复制 Red Hat OpenStack Platform 数据库。

- Memcached - 提供数据库缓存服务。

- 自版本 13 起,您可以使用 director 部署计算实例的高可用性 (Instance HA)。使用 Instance HA,当 Compute 节点出现故障时,可以自动清空该 Compute 节点上的实例。

1.4. 容器化

undercloud 和 overcloud 上的各个 OpenStack Platform 服务在对应节点的单独 Linux 容器内运行。这种容器化提供了一种隔离服务、维护环境和升级 OpenStack Platform 的方法。

Red Hat OpenStack Platform 15 支持安装在 Red Hat Enterprise Linux 8 操作系统上。Red Hat Enterprise Linux 8 不再包含 Docker,并提供一组新的工具替换 Docker 生态系统。这意味着 OpenStack Platform 15 使用这些新工具替换 Docker 进行 OpenStack Platform 部署和升级。

- Podman

Pod Manager (Podman) 是容器管理工具。它几乎实现所有 Docker CLI 命令,但不包括与 Docker Swarm 相关的命令。Podman 管理 pod、容器和容器镜像。Podman 和 Docker 之间的一个主要差异是 Podman 可以在后台没有运行守护进程的情况下管理资源。

有关 Podman 的更多信息,请访问 Podman 网站。

- Buildah

Buildah 专门构建您与 Podman 一起使用的 Open Containers Initiative (OCI) 镜像。Buildah 命令可以实现 Dockerfile 的功能。Buildah 还提供一个较低级别的

coreutils接口以构建容器镜像,帮助您在无需 Dockerfile 的情况下构建容器。Buildah 还使用其他脚本语言在无需守护进程的情况下构建容器镜像。有关 Buildah 的更多信息,请访问 Buildah 网站。

- Skopeo

- Skopeo 使操作员能够检查远程容器镜像,帮助 director 在拉取镜像时收集数据。其他功能包括在 registry 间复制容器镜像,以及从 registry 中删除镜像。

红帽支持多种方式为您的 overcloud 获取容器镜像:

- 直接从红帽容器目录中拉取容器镜像

- 将容器镜像托管在 undercloud 上

- 将容器镜像托管在 Satellite 6 服务器上

本指南包含有关配置容器镜像 registry 的详细信息和执行基本容器操作的信息。

1.5. Ceph 存储

大型的机构通常需要使用 OpenStack 来为成千上万的客户端系统提供服务,而每个 OpenStack 客户端系统都会有自己对块存储资源的要求。在一个单一的节点上安装 glance (images)、cinder (volumes) 和/或 nova (compute) 来管理一个大型系统中的成千上万的客户系统将变得非常不现实。在单个节点上部署 glance(镜像)、cinder(卷)和/或 nova(计算)可能无法管理具有数千客户端的大型部署。在外部扩展 OpenStack 可解决此问题。

但是,在实际的环境中,仍然需要一个存储层的虚拟化解决方案来扩展 Red Hat OpenStack Platform 的存储层,使它可以支持 terabyte、petabyte 甚至 exabyte 数量级的存储要求。Red Hat Ceph Storage 提供了这样一个存储虚拟化层,它具有高可用性和高效性。尽管虚拟化可能看似会影响性能,Ceph 会将块设备镜像以条带化的形式作为对象分布在集群中上的对象,这意味着大型 Ceph Block Device 镜像的性能实际上比独立磁盘性能更好。另外,Cept Block 设备还支持缓存、copy-on-write cloning 和 copy-on-read cloning 功能来提高性能。

有关 Red Hat Ceph Storage 的更多信息,请参阅 Red Hat Ceph Storage。

对于多架构云,红帽仅支持预安装或外部 Ceph 实施。有关详细信息,请参阅将 Overcloud 与现有 Red Hat Ceph 集群集成和 附录 B, Red Hat OpenStack Platform for POWER。

部分 I. director 的安装和配置

第 2 章 规划您的 undercloud

2.1. 容器化 undercloud

undercloud 是控制最终 OpenStack 平台环境(称为 overcloud)的配置、安装和管理的节点。undercloud 本身以容器形式使用 OpenStack Platform 组件来创建称为 OpenStack Platform director 的工具集。这意味着,undercloud 从注册表来源拉取一组镜像容器,生成容器的配置,然后以容器的形式运行各项 OpenStack Platform 服务。因此,undercloud 提供一组容器化服务,您可以将这些服务用作创建和管理 overcloud 的工具集。

undercloud 和 overcloud 都使用容器,它们使用相同的架构来拉取、配置和运行容器。此架构基于用于置备节点的 OpenStack Orchestration 服务 (heat) 并使用 Ansible 配置服务和容器。熟悉 Heat 和 Ansible 有助于诊断您可能遇到的问题。

2.2. 准备 undercloud 网络

undercloud 需要访问两个主要网络:

- Provisioning 网络或 Control Plane 网络,这是 director 用于置备节点和在执行 Ansible 配置时通过 SSH 访问这些节点的网络。此网络还支持从 undercloud 到 overcloud 节点的 SSH 访问。undercloud 包含在此网络上内省和置备其他节点的 DHCP 服务,这意味着此网络上不应存在其他 DHCP 服务。director 为此网络配置接口。

- External 网络,支持访问 OpenStack Platform 软件仓库、容器镜像源和 DNS 服务器或 NTP 服务器等的其他服务器。使用此网络从您的工作站对 undercloud 进行标准访问。您必须在 undercloud 上手动配置一个接口以访问外部网络。

undercloud 至少需要 2 个 1 Gbps 网络接口卡:一个用于Provisioning 或 Control Plane 网络,一个用于External 网络。不过,建议为 Provisioning 网络流量使用 10 Gbps 接口,特别是在 overcloud 环境中置备大量节点时。

请注意:

- 确保 Provisioning / Control Plane NIC 不是您用于从工作站访问 director 机器的 NIC。director 安装会使用 Provisioning NIC 创建一个网桥,它会忽略所有远程连接。使用 External NIC 来远程连接 director 系统。

Provisioning 网络需要一个与您的环境大小相匹配的 IP 范围。使用以下原则来决定包括在这个范围内的 IP 地址数量:

- 至少包括一个临时 IP 地址,用于内省期间连接到 Provisioning 网络的每个节点。

- 至少包括一个永久 IP 地址,用于部署期间连接到 Provisioning 网络的每个节点。

- 包括一个额外的 IP 地址,用于 Provisioning 网络上 overcloud 高可用性集群的虚拟 IP。

- 包括一个此范围内的额外 IP 地址,以用于扩展环境。

2.3. 确定环境规模

在安装 undercloud 前,建议确定环境的规模。规划环境时应考虑到以下因素:

- 您的 overcloud 中有多少个节点? undercloud 管理 overcloud 中的每个节点。置备 overcloud 节点会消耗 undercloud 上的资源。您必须为 undercloud 提供足够的资源用来置备和控制 overcloud 节点。

- 您希望 undercloud 同步执行多少个操作? undercloud 上的大部分 OpenStack 服务会使用一组 workers。每个 worker 执行特定于该服务的一个操作。多个 worker 提供同步操作。undercloud 上 worker 的默认数量是 undercloud 的 CPU 线程总数的一半[1]。例如,如果 undercloud 的 CPU 具有 16 个线程,则 heat 默认生成 8 个 worker。director 还默认使用一组最小值和最大值

| 服务 | 最小值 | 最大值 |

|---|---|---|

| OpenStack Orchestration (heat) | 4 | 24 |

| 所有其他服务 | 2 | 12 |

undercloud 具有最小 CPU 和内存要求:

- 支持 Intel 64 或 AMD64 CPU 扩展的 8 线程 64 位 x86 处理器。这可为每个 undercloud 服务提供 4 个 worker。

最少 24 GB RAM。

-

每 10 个由 undercloud 部署的主机,

ceph-ansibleplaybook 占用 1 GB 常驻集合大小 (RSS)。如果部署的 overcloud 会使用现有 Ceph 集群,或会部署新的 Ceph 集群,则相应置备 undercloud RAM。

-

每 10 个由 undercloud 部署的主机,

要使用更多 worker,使用以下建议增加 undercloud 的 vCPU 和内存:

- 最小值:每个线程使用 1.5 GB 内存。例如,一台有 48 个线程的计算机应当具有 72 GB RAM。这可以为 24 个 Heat worker 和 12 个用于其他服务的 worker 提供最小的覆盖范围。

- 建议值:每个线程使用 3 GB 内存。例如,一台有 48 个线程的计算机应当具有 144 GB RAM。这可以为 24 个 Heat worker 和 12 个用于其他服务的 worker 提供建议的覆盖范围。

2.4. undercloud 磁盘大小调整

建议的最小 undercloud 磁盘大小为在根磁盘上有 100 GB 可用磁盘空间:

- 20 GB 用于容器镜像

- 10 GB 在节点部署过程中用于 QCOW2 镜像转换和缓存

- 70 GB 或更大空间供常规使用、保存日志和指标以及满足增长需要

2.5. undercloud 软件仓库

启用以下软件仓库用于安装和配置 undercloud。

核心软件仓库

下表列出了用于安装 undercloud 的核心软件仓库。

| 名称 | 软件仓库 | 描述 |

|---|---|---|

| Red Hat Enterprise Linux 8 for x86_64 - BaseOS (RPMs) |

| x86_64 系统的基本操作系统仓库。 |

| Red Hat Enterprise Linux 8 for x86_64 - AppStream (RPMs) |

| 包括 Red Hat OpenStack Platform 的依赖软件包。 |

| Red Hat Enterprise Linux 8 for x86_64 - High Availability (RPMs) |

| Red Hat Enterprise Linux 的高可用性工具。用于 Controller 节点的高可用性功能。 |

| Red Hat Ansible Engine 2.8 for RHEL 8 x86_64 (RPMs) |

| 适用于 Red Hat Enterprise Linux 的 Ansible Engine。用于提供最新版本的 Ansible。 |

| Advanced Virtualization for RHEL 8 x86_64 (RPMs) |

| 为 OpenStack Platform 提供虚拟化软件包。 |

| Red Hat Satellite Tools for RHEL 8 Server RPMs x86_64 |

| 管理使用 Red Hat Satellite 6 的主机的工具。 |

| Red Hat OpenStack Platform 15 for RHEL 8 (RPMs) |

| Red Hat OpenStack Platform 核心软件仓库,包含 Red Hat OpenStack Platform director 的软件包。 |

Ceph 软件仓库

下表列出了用于 undercloud 的与 Ceph Storage 有关的软件仓库。

| 名称 | 软件仓库 | 描述 |

|---|---|---|

| Red Hat Ceph Storage Tools 4 for RHEL 8 x86_64 (RPMs) |

|

提供节点与 Ceph Storage 集群进行通信的工具。如果计划在 overcloud 中使用 Ceph Storage,undercloud 需要此软件仓库中的 |

IBM POWER 软件仓库

下表列出了用于 Openstack Platform on POWER PC 架构的软件仓库。使用这些软件仓库来替代核心软件仓库中的同等库。

| 名称 | 软件仓库 | 描述 |

|---|---|---|

| Red Hat Enterprise Linux for IBM Power, little endian - BaseOS (RPMs) |

| ppc64le 系统的基本操作系统软件仓库。 |

| Red Hat Enterprise Linux 8 for IBM Power, little endian - AppStream (RPMs) |

| 包括 Red Hat OpenStack Platform 的依赖软件包。 |

| Red Hat Enterprise Linux 8 for IBM Power, little endian - High Availability (RPMs) |

| Red Hat Enterprise Linux 的高可用性工具。用于 Controller 节点的高可用性功能。 |

| Red Hat Ansible Engine 2.8 for RHEL 8 IBM Power, little endian (RPMs) |

| 适用于 Red Hat Enterprise Linux 的 Ansible Engine。用于提供最新版本的 Ansible。 |

| Red Hat OpenStack Platform 15 for RHEL 8 (RPMs) |

| 用于 ppc64le 系统的 Red Hat OpenStack Platform 核心软件仓库。 |

第 3 章 director 安装准备

3.1. 准备 undercloud

director 安装需要以下项目:

- 一个用来执行命令的非 root 用户。

- 用于组织镜像和模板的目录。

- 一个可解析的主机名

- 一个红帽订阅

- 用于准备镜像和安装 director 的命令行工具

此过程显示如何创建这些项目。

步骤

-

以

root用户身份登录 undercloud。 创建

stack用户:[root@director ~]# useradd stack

为该用户设置密码:

[root@director ~]# passwd stack

进行以下操作,以使用户在使用

sudo时无需输入密码:[root@director ~]# echo "stack ALL=(root) NOPASSWD:ALL" | tee -a /etc/sudoers.d/stack [root@director ~]# chmod 0440 /etc/sudoers.d/stack

切换到新的

stack用户:[root@director ~]# su - stack [stack@director ~]$

为系统镜像和 Heat 模板创建目录。

[stack@director ~]$ mkdir ~/images [stack@director ~]$ mkdir ~/templates

director 使用系统镜像和 Heat 模板来创建 overcloud 环境。红帽建议创建这些目录来帮助您组织本地文件系统。

检查 undercloud 的基础和完整主机名:

[stack@director ~]$ hostname [stack@director ~]$ hostname -f

如果上述命令没有显示正确的完全限定主机名或报告错误,则使用

hostnamectl设置主机名:[stack@director ~]$ sudo hostnamectl set-hostname manager.example.com [stack@director ~]$ sudo hostnamectl set-hostname --transient manager.example.com

编辑

/etc/hosts以包括系统主机名的一个条目。/etc/hosts中的 IP 地址必须与您计划用于 undercloud 公共 API 的地址匹配。例如,如果系统名是manager.example.com,其使用的 IP 地址是10.0.0.1,/etc/hosts则需要包括一个与以下内容类似的条目:10.0.0.1 manager.example.com manager

在红帽 Content Delivery Network 或 Red Hat Satellite 注册您的系统。例如,运行以下命令在 Content Delivery Network 中注册系统。根据提示输入您的客户门户网站用户名和密码:

[stack@director ~]$ sudo subscription-manager register

查找 Red Hat OpenStack Platform director 的权利池 ID。例如:

[stack@director ~]$ sudo subscription-manager list --available --all --matches="Red Hat OpenStack" Subscription Name: Name of SKU Provides: Red Hat Single Sign-On Red Hat Enterprise Linux Workstation Red Hat CloudForms Red Hat OpenStack Red Hat Software Collections (for RHEL Workstation) Red Hat Virtualization SKU: SKU-Number Contract: Contract-Number Pool ID: Valid-Pool-Number-123456 Provides Management: Yes Available: 1 Suggested: 1 Service Level: Support-level Service Type: Service-Type Subscription Type: Sub-type Ends: End-date System Type: Physical找到

池 ID值并附加 Red Hat OpenStack Platform 15 权利:[stack@director ~]$ sudo subscription-manager attach --pool=Valid-Pool-Number-123456

禁用所有默认的仓库,然后启用 Red Hat Enterprise Linux 仓库:

[stack@director ~]$ sudo subscription-manager repos --disable=* [stack@director ~]$ sudo subscription-manager repos --enable=rhel-8-for-x86_64-baseos-rpms --enable=rhel-8-for-x86_64-appstream-rpms --enable=rhel-8-for-x86_64-highavailability-rpms --enable=ansible-2.8-for-rhel-8-x86_64-rpms --enable=openstack-15-for-rhel-8-x86_64-rpms --enable=fast-datapath-for-rhel-8-x86_64-rpms --enable=advanced-virt-for-rhel-8-x86_64-rpm

这些仓库包括了安装 director 所需的软件包。

在系统上执行更新,确保您有最新的基本系统软件包:

[stack@director ~]$ sudo yum update -y [stack@director ~]$ sudo reboot

安装用于安装和配置 director 的命令行工具:

[stack@director ~]$ sudo yum install -y python3-tripleoclient

3.2. 安装 ceph-ansible

如果您计划创建带有 Ceph Storage 节点的 overcloud,则按以下步骤安装 ceph-ansible 软件包。如果您不打算在 overcloud 中创建 Ceph Storage 节点,则不需要此软件包。

步骤

安装 ceph-ansible 软件包:

[stack@director ~]$ sudo yum install -y ceph-ansible

ceph-ansible 版本 4 的更新版本将在 openstack-15-for-rhel-8-x86_64-rpms 软件仓库中提供,直至 Red Hat Ceph Storage 版本 4 正式发布(GA)。当 Red Hat Ceph Storage 版本 4 正式发布后,则从 rhceph-4-tools-for-rhel-8-x86_64-rpms 软件仓库中安装 ceph-ansible。

3.3. 准备容器镜像

undercloud 配置需要进行初始 registry 配置,以确定获取镜像的位置和存储方式。完成以下步骤,生成并自定义环境文件用于准备您的容器镜像。

步骤

- 以 stack 用户身份登录 undercloud 主机。

生成默认的容器镜像准备文件:

$ openstack tripleo container image prepare default \ --local-push-destination \ --output-env-file containers-prepare-parameter.yaml

此命令包括以下附加选项:

-

--local-push-destination,在 undercloud 上设置 registry 作为存储容器镜像的位置。这意味着 director 从红帽容器目录中拉取必要的镜像并将其推送到 undercloud 上的 registry 中。director 将该 registry 用作容器镜像源。如果直接从红帽 Container Catalog 目录拉取镜像,请忽略这个选项。 --output-env-file是环境文件名称。此文件的内容包括用于准备您的容器镜像的参数。在本例中,文件的名称是containers-prepare-parameter.yaml。注意您也可以使用相同的

containers-prepare-parameter.yaml文件为 undercloud 和 overcloud 定义容器镜像源。

-

-

编辑

containers-prepare-parameter.yaml并进行修改以符合您的需求。

3.4. 容器镜像准备参数

用于准备您的容器的默认文件 (containers-prepare-parameter.yaml) 包含 ContainerImagePrepare Heat 参数。此参数定义一个用于准备一系列镜像的策略列表:

parameter_defaults: ContainerImagePrepare: - (strategy one) - (strategy two) - (strategy three) ...

每一策略接受一组子参数,它们定义要使用哪些镜像以及如何对待它们。下表包含有关您可与每个 ContainerImagePrepare 策略配合使用的子参数的信息:

| 参数 | 描述 |

|---|---|

|

| 从策略中排除的镜像名称子字符串列表。 |

|

|

包括在策略中的镜像名称子字符串列表。至少一个镜像名称必须与现有镜像匹配。如果指定了 |

|

|

要附加到目标镜像标签的字符串。例如,如果使用标签 |

|

| 过滤镜像进行修改的镜像标签字典。如果镜像与定义的标签匹配,则 director 将该镜像包括在修改过程中。 |

|

| 在上传期间但在将镜像推送到目标 registry 之前运行的 ansible 角色名称字符串。 |

|

|

要传递给 |

|

|

用于在上传过程中推送镜像的注册表的命名空间。当为这个参数指定了一个命名空间后,所有镜像参数也会使用这个命名空间。如果设为 |

|

| 从中拉取原始容器镜像的源 registry 。 |

|

|

用于定义从何处获取初始镜像的 |

|

|

定义标记 (tag) 生成的镜像的标签特征。通常设置为 |

set 参数接受一组 key: value 定义。下表包含键的相关信息:

| 键 | 描述 |

|---|---|

|

| Ceph Storage 容器镜像的名称。 |

|

| Ceph Storage 容器镜像的命名空间。 |

|

| Ceph Storage 容器镜像的标签。 |

|

| 各个 OpenStack 服务镜像的前缀。 |

|

| 各个 OpenStack 服务镜像的后缀。 |

|

| 各个 OpenStack 服务镜像的命名空间。 |

|

|

用于确定要使用的 OpenStack Networking (neutron) 容器的驱动程序。null 值代表使用标准的 |

|

|

director 用于识别要从源 registry 中拉取的镜像的标签。这个项通常会被设置为 |

ContainerImageRegistryCredentials 参数将容器 registry 映射到用户名和密码以对该 registy 进行验证。

如果容器 registry 需要用户名和密码,则可使用 ContainerImageRegistryCredentials 以下语法包括它们的值:

ContainerImagePrepare:

- push_destination: 192.168.24.1:8787

set:

namespace: registry.redhat.io/...

...

ContainerImageRegistryCredentials:

registry.redhat.io:

my_username: my_password

在示例中,用身份验证凭据替换 my_username 和 my_password。红帽建议创建一个 registry 服务帐户并使用这些凭据访问 registry.redhat.io 内容,而不使用您的个人用户凭据。有关更多信息,请参阅“红帽容器 registry 身份验证”。

3.5. 分层镜像准备条目

ContainerImagePrepare 参数的值是一个 YAML 列表。这意味着您可以指定多个条目。以下示例带有两个条目,director 使用所有镜像的最新版本,nova-api 镜像除外,该镜像使用标记为 15.0-44 的版本:

ContainerImagePrepare:

- tag_from_label: "{version}-{release}"

push_destination: true

excludes:

- nova-api

set:

namespace: registry.redhat.io/rhosp15-rhel8

name_prefix: openstack-

name_suffix: ''

tag: latest

- push_destination: true

includes:

- nova-api

set:

namespace: registry.redhat.io/rhosp15-rhel8

tag: 15.0-44

includes 和 excludes 条目控制每个条目的镜像过滤。匹配 includes 策略的镜像的优先级高于 excludes 匹配项。镜像名称必须包括 includes 或 excludes 值才被认为匹配。

3.6. 从私有 registry 获取容器镜像

有些容器镜像 registry 可能需要进行身份验证才能访问镜像。在这种情况下,请使用您的 containers-prepare-parameter.yaml 环境文件中的 ContainerImageRegistryCredentials 参数。

parameter_defaults:

ContainerImagePrepare:

- (strategy one)

- (strategy two)

- (strategy three)

ContainerImageRegistryCredentials:

registry.example.com:

username: "p@55w0rd!"

私有 registry 需要针对其在 ContainerImagePrepare 中的相应策略将 push_destination 设置为 true。

ContainerImageRegistryCredentials 参数使用一组基于私有 registry URL 的键。每个私有 registry URL 使用其自己的键和值对定义用户名(键)和密码(值)。这提供了一种为多个私有 registry 指定凭据的方法。

parameter_defaults:

...

ContainerImageRegistryCredentials:

registry.redhat.io:

myuser: 'p@55w0rd!'

registry.internalsite.com:

myuser2: '0th3rp@55w0rd!'

'192.0.2.1:8787':

myuser3: '@n0th3rp@55w0rd!'

默认 ContainerImagePrepare 参数从需要进行身份验证的 registry.redhat.io 中拉取 Ceph Storage 容器镜像。

3.7. 准备期间修改镜像

可在准备镜像期间修改镜像,然后立即使用修改的镜像部署。修改镜像的情况包括:

- 作为连续集成管道的一个部分,在部署之前使用要测试的更改修改镜像。

- 作为开发工作流的一个部分,需要部署本地更改以进行测试和开发。

- 需要部署更改,但更改没有通过镜像构建管道提供。例如,添加专有附加组件或紧急修复。

要在准备期间修改镜像,可在您要修改的每个镜像上调用 Ansible 角色。该角色提取源镜像,进行请求的更改,并标记结果。准备命令可将镜像推送到目标 registry,并设置 Heat 参数以引用修改的镜像。

Ansible 角色 tripleo-modify-image 与所需的角色接口相一致,并提供修改用例必需的行为。使用 ContainerImagePrepare 参数中与修改相关的键控制修改:

-

modify_role指定要为每个镜像调用的 Ansible 角色进行修改。 -

modify_append_tag将字符串附加到源镜像标签的末尾。这可以标明生成的镜像已被修改过。如果push_destinationregistry 已包含修改的镜像,则使用此参数跳过修改。建议在每次修改镜像时都更改modify_append_tag。 -

modify_vars是要传递给角色的 Ansible 变量的字典。

要选择 tripleo-modify-image 角色处理的用例,将 tasks_from 变量设置为该角色中所需的文件。

在开发和测试修改镜像的 ContainerImagePrepare 条目时,建议运行镜像准备命令(无需任何其他选项),以确认镜像已如期修改:

sudo openstack tripleo container image prepare \ -e ~/containers-prepare-parameter.yaml

3.8. 更新容器镜像的现有软件包

以下示例 ContainerImagePrepare 条目使用 undercloud 主机的 yum 软件仓库配置在镜像的所有软件包中更新:

ContainerImagePrepare:

- push_destination: true

...

modify_role: tripleo-modify-image

modify_append_tag: "-updated"

modify_vars:

tasks_from: yum_update.yml

compare_host_packages: true

yum_repos_dir_path: /etc/yum.repos.d

...3.9. 将额外的 RPM 文件安装到容器镜像中

您可以在容器镜像中安装 RPM 文件的目录。这对安装修补程序、本地软件包内部版本或任何通过软件包仓库无法获取的软件包都非常有用。例如,以下 ContainerImagePrepare 条目仅在 nova-compute 镜像上安装一些修补程序包:

ContainerImagePrepare:

- push_destination: true

...

includes:

- nova-compute

modify_role: tripleo-modify-image

modify_append_tag: "-hotfix"

modify_vars:

tasks_from: rpm_install.yml

rpms_path: /home/stack/nova-hotfix-pkgs

...3.10. 通过自定义 Dockerfile 修改容器镜像

要获得最大的灵活性,您可以指定一个包含 Dockerfile 的目录进行所需更改。调用 tripleo-modify-image 角色时,该角色生成 Dockerfile.modified 文件,而该文件更改 FROM 指令并添加额外的 LABEL 指令。以下示例在 nova-compute 镜像上运行自定义 Dockerfile:

ContainerImagePrepare:

- push_destination: true

...

includes:

- nova-compute

modify_role: tripleo-modify-image

modify_append_tag: "-hotfix"

modify_vars:

tasks_from: modify_image.yml

modify_dir_path: /home/stack/nova-custom

...

例如 /home/stack/nova-custom/Dockerfile。运行任何 USER 根指令后,必须切换回原始镜像默认用户:

FROM registry.redhat.io/rhosp15-rhel8/openstack-nova-compute:latest USER "root" COPY customize.sh /tmp/ RUN /tmp/customize.sh USER "nova"

3.11. 为容器镜像准备 Satellite 服务器

Red Hat Satellite 6 提供了注册表同步功能。通过该功能可将多个镜像提取到 Satellite 服务器中,作为应用程序生命周期的一部分加以管理。Satellite 也可以作为 registry 供其他启用容器功能的系统使用。有关管理容器镜像的更多信息,请参阅 Red Hat Satellite 6 内容管理指南中的“管理容器镜像”。

以下操作过程示例中使用了 Red Hat Satellite 6 的 hammer 命令行工具和一个名为 ACME 的示例组织。请将该组织替换为您自己 Satellite 6 中的组织。

此过程需要身份验证凭据以从 registry.redhat.io 访问容器镜像。红帽建议创建一个 registry 服务帐户并使用这些凭据访问 registry.redhat.io 内容,而不使用您的个人用户凭据。有关更多信息,请参阅“红帽容器 registry 身份验证”。

步骤

创建所有容器镜像的列表:

$ sudo podman search --limit 1000 "registry.redhat.io/rhosp15-rhel8" | awk '{ print $2 }' | grep -v beta | sed "s/registry.redhat.io\///g" | tail -n+2 > satellite_images-

将

satellite_images_names文件复制到包含 Satellite 6hammer工具的系统中。或者,根据 Hammer CLI 指南中的说明将hammer工具安装到 undercloud 中。 运行以下

hammer命令以在 Satellite 组织中创建新产品(OSP15 容器):$ hammer product create \ --organization "ACME" \ --name "OSP15 Containers"

该定制产品将会包含我们的镜像。

为产品添加基本容器镜像:

$ hammer repository create \ --organization "ACME" \ --product "OSP15 Containers" \ --content-type docker \ --url https://registry.redhat.io \ --docker-upstream-name rhosp15-rhel8/openstack-base \ --upstream-username USERNAME \ --upstream-password PASSWORD \ --name base

添加

satellite_images文件中的 overcloud 容器镜像。$ while read IMAGE; do \ IMAGENAME=$(echo $IMAGE | cut -d"/" -f2 | sed "s/openstack-//g" | sed "s/:.*//g") ; \ hammer repository create \ --organization "ACME" \ --product "OSP15 Containers" \ --content-type docker \ --url https://registry.redhat.io \ --docker-upstream-name $IMAGE \ --upstream-username USERNAME \ --upstream-password PASSWORD \ --name $IMAGENAME ; done < satellite_images_names

添加 Ceph Storage 4 容器镜像:

$ hammer repository create \ --organization "ACME" \ --product "OSP15 Containers" \ --content-type docker \ --url https://registry.redhat.io \ --docker-upstream-name rhceph-beta/rhceph-4-rhel8 \ --upstream-username USERNAME \ --upstream-password PASSWORD \ --name rhceph-4-rhel8

同步容器镜像:

$ hammer product synchronize \ --organization "ACME" \ --name "OSP15 Containers"

等待 Satellite 服务器完成同步。

注意根据具体配置情况,

hammer可能会询问您的 Satellite 服务器用户名和密码。您可以使用配置文件将hammer配置为自动登录。有关更多信息,请参阅 Hammer CLI 指南中的“身份验证”章节。-

如果您的 Satellite 6 服务器使用内容视图,请创建一个用于纳入镜像的新内容视图版本,并在应用生命周期的不同环境之间推进这个视图。这在很大程度上取决于您如何构建应用程序的生命周期。例如,如果您的生命周期中有一个称为

production的环境,并且希望容器镜像在该环境中可用,则创建一个包含容器镜像的内容视图,并将该内容视图推进到production环境中。有关更多信息,请参阅“使用内容视图管理容器镜像”。 检查

base镜像的可用标签:$ hammer docker tag list --repository "base" \ --organization "ACME" \ --environment "production" \ --content-view "myosp15" \ --product "OSP15 Containers"

此命令显示内容视图中特定环境的 OpenStack Platform 容器镜像的标签。

返回到 undercloud,并生成默认的环境文件(将您的 Satellite 服务器用作源来准备镜像)。运行以下示例命令以生成环境文件:

(undercloud) $ openstack tripleo container image prepare default \ --output-env-file containers-prepare-parameter.yaml

-

--output-env-file是环境文件名称。此文件的内容包括用于为 undercloud 准备容器镜像的参数。在本例中,文件的名称是containers-prepare-parameter.yaml。

-

编辑

containers-prepare-parameter.yaml文件并修改以下参数:-

namespace- Satellite 服务器上注册表的 URL 和端口。Red Hat Satellite 上的默认注册表端口是 5000。 name_prefix- 该前缀基于 Satellite 6 规范。它的值根据您是否使用了内容视图而不同:-

如果您使用了内容视图,则前缀的结构为

[组织]-[环境]-[内容视图]-[产品]-。例如:acme-production-myosp15-osp15_containers-。 -

如果不使用内容视图,则前缀的结构为

[组织]-[产品]-。例如:acme-osp15_containers-。

-

如果您使用了内容视图,则前缀的结构为

-

ceph_namespace、ceph_image、ceph_tag- 如果正在使用 Ceph Storage,请额外纳入这些参数以定义 Ceph Storage 容器镜像的位置。请注意,ceph_image现包含特定于 Satellite 的前缀。这个前缀与name_prefix选项的值相同。

-

以下示例环境文件包含特定于 Satellite 的参数:

parameter_defaults:

ContainerImagePrepare:

- push_destination: true

set:

ceph_image: acme-production-myosp15-osp15_containers-rhceph-4

ceph_namespace: satellite.example.com:5000

ceph_tag: latest

name_prefix: acme-production-myosp15-osp15_containers-

name_suffix: ''

namespace: satellite.example.com:5000

neutron_driver: null

tag: latest

...

tag_from_label: '{version}-{release}'在创建 undercloud 和 overcloud 时使用此环境文件。

第 4 章 安装 director

4.1. 配置 director

director 安装过程需要 undercloud.conf 配置文件中的某些设置,director 从 stack 用户的主目录中读取该文件。以下操作过程展示了如何基于这个默认模板来进行配置。

步骤

将默认模板复制到

stack用户的主目录:[stack@director ~]$ cp \ /usr/share/python-tripleoclient/undercloud.conf.sample \ ~/undercloud.conf

-

编辑

undercloud.conf文件。这个文件包含用于配置 undercloud 的设置。如果忽略或注释掉某个参数,undercloud 安装将使用默认值。

4.2. Director 配置参数

以下列表包含用于配置 undercloud.conf 文件的参数的相关信息。将所有参数保留在相关部分内以避免出错。

默认值

以下参数会在 undercloud.conf 文件的 [DEFAULT] 部分中进行定义:

- additional_architectures

overcloud 支持的附加(内核)架构的列表。overcloud 目前支持

ppc64le架构。注意如果启用了 ppc64le,您也必须将

ipxe_enabled设为False- certificate_generation_ca

-

为所请求证书签名的 CA 的

certmonger别名。仅在设置了generate_service_certificate参数的情况下使用此选项。如果您选择localCA,certmonger 会将本地 CA 证书提取到/etc/pki/ca-trust/source/anchors/cm-local-ca.pem并将该证书添加到信任链中。 - clean_nodes

- 确定是否在部署之间和内省之后擦除硬盘。

- cleanup

-

清理临时文件。将此选项设置为

False,可在该命令运行后保留部署期间使用的临时文件。这可用于调试生成的文件或者确定是否发生了错误。 - container_cli

-

用于容器管理的 CLI 工具。保留此参数设为

podman,因为 Red Hat Enterprise Linux 8 仅支持podman。 - container_healthcheck_disabled

-

禁用容器化服务运行状况检查。建议启用运行状况检查,并让此选项设为

false。 - container_images_file

含有容器镜像信息的 Heat 环境文件。这可以是:

- 所有需要的容器镜像的参数

-

或

ContainerImagePrepare参数(用于推动必要的容器准备)。通常,含有此参数的文件被命名为containers-prepare-parameter.yaml。

- container_insecure_registries

-

供

podman使用的不安全 registry 列表。如果您想从其他来源(如私有容器 registry)拉取镜像,则使用此参数。在大多数情况下,如果在 Satellite 中注册了 undercloud,podman就有从红帽容器目录或 Satellite 服务器拉取容器镜像的证书。 - container_registry_mirror

-

配置的

podman使用的可选registry-mirror。 - custom_env_files

- 要添加到 undercloud 安装中的其他环境文件。

- deployment_user

-

安装 undercloud 的用户。如果此参数保留为不设置,则使用当前的默认用户 (

stack)。 - discovery_default_driver

-

为自动注册的节点设置默认驱动器。需要启用

enable_node_discovery,且必须在enabled_drivers列表中包含驱动器。 - enable_ironic、enable_ironic_inspector、enable_mistral、enable_tempest、enable_validations、enable_zaqar

-

定义要为 director 启用的核心服务。保留这些参数设为

true。 - enable_node_discovery

-

自动注册通过 PXE 引导内省虚拟内存盘(ramdisk)的所有未知节点。新节点使用

fake_pxe作为默认驱动器,但您可以设置discovery_default_driver覆盖它。您也可以使用内省规则为新注册的节点指定驱动器信息。 - enable_novajoin

-

定义是否在 undercloud 中安装

novajoin元数据服务。 - enable_routed_networks

- 定义是否支持路由的 control plane 网络。

- enable_swift_encryption

- 定义是否启用 Swift 加密。

- enable_telemetry

-

定义是否在 undercloud 中安装 OpenStack Telemetry 服务(gnocchi、aodh、panko)。如果您想自动安装和配置 telemetry 服务,则将

enable_telemetry参数设为true。默认值为false,即在 undercloud 中禁用遥测。如果使用要利用指标数据的其他产品,如 Red Hat CloudForms,则需要这个参数。 - enabled_hardware_types

- 要为 undercloud 启用的硬件类型的列表。

- generate_service_certificate

-

定义 undercloud 安装期间是否生成 SSL/TLS 证书,此证书用于

undercloud_service_certificate参数。undercloud 安装会保存生成的证书/etc/pki/tls/certs/undercloud-[undercloud_public_vip].pem。certificate_generation_ca参数中定义的 CA 将为此证书签名。 - heat_container_image

- 要使用的 heat 容器镜像的 URL。请保留不设置。

- heat_native

-

使用原生 heat 模板。请保留为

true。 - hieradata_override

-

在 director 上配置 Puppet hieradata 的

hieradata覆盖文件的路径,为undercloud.conf参数外的服务提供自定义配置。如果设置此参数,undercloud 安装会将此文件复制到/etc/puppet/hieradata目录并将其设为层次结构中的第一个文件。有关使用此功能的详细信息,请参阅在 undercloud 上配置 hieradata。 - inspection_extras

-

指定在内省的过程中是否启用额外的硬件集合。此参数在内省镜像上需要

python-hardware或python-hardware-detect软件包。 - inspection_interface

-

director 用来进行节点内省的网桥。这是 director 配置创建的自定义网桥。

LOCAL_INTERFACE会附加到这个网桥。请保留使用默认的值(br-ctlplane)。 - inspection_runbench

-

在节点内省过程中运行一组基准测试。将此参数设为

true以启用基准测试。如果您需要在检查注册节点的硬件时执行基准数据分析操作,则需要使用这个参数。 - ipa_otp

-

定义在 IPA 服务器注册 undercloud 节点使用的一次性密码。启用

enable_novajoin之后需要提供此密码。 - ipxe_enabled

-

定义使用 iPXE 还是标准的 PXE。默认为

true,其启用 iPXE。设为false以设置为标准 PXE。 - local_interface

指定 director 的 Provisioning NIC 的接口。这也是 director 用于 DHCP 和 PXE 引导服务的设备。把这个项的值改为您需要使用的值。使用

ip addr命令可以查看连接了哪些设备。以下是一个ip addr命令的结果输出示例:2: eth0: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc pfifo_fast state UP qlen 1000 link/ether 52:54:00:75:24:09 brd ff:ff:ff:ff:ff:ff inet 192.168.122.178/24 brd 192.168.122.255 scope global dynamic eth0 valid_lft 3462sec preferred_lft 3462sec inet6 fe80::5054:ff:fe75:2409/64 scope link valid_lft forever preferred_lft forever 3: eth1: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc noop state DOWN link/ether 42:0b:c2:a5:c1:26 brd ff:ff:ff:ff:ff:ff在这个例子中,External NIC 使用

eth0,Provisioning NIC 使用eth1(当前没有被配置)。在这种情况下,把local_interface设置为eth1。配置脚本会把这个接口附加到一个自定义的网桥(由inspection_interface参数定义)上。- local_ip

-

director 的 Provisioning NIC 的 IP 地址。这也是 director 用于 DHCP 和 PXE 引导服务的 IP 地址。除非 Provisioning 网络需要使用其他子网(如因为与环境中的现有 IP 地址或子网冲突)保留默认值

192.168.24.1/24。 - local_mtu

-

用于

local_interface的 MTU。 - local_subnet

-

适用于 PXE 引导和 DHCP 接口的本地子网。

local_ip地址应该属于这个子网。默认值为ctlplane-subnet。 - net_config_override

-

网络配置覆盖模板的路径。如果设置此参数,undercloud 将使用 JSON 格式模板以使用

os-net-config配置网络。undercloud 会忽略undercloud.conf中设置的网络参数。如需示例,请参阅/usr/share/python-tripleoclient/undercloud.conf.sample。 - networks_file

-

覆盖用于

heat的网络文件。 - output_dir

- 输出状态目录、处理的 heat 模板和 Ansible 部署文件。

- overcloud_domain_name

要在部署 overcloud 时使用的 DNS 域名。

注意配置 overcloud 时,

CloudDomain参数必须设为匹配值。配置 overcloud 时,在环境文件中设置此参数。- roles_file

- 覆盖用于 undercloud 安装的角色文件。强烈建议您保留为不设置,以便 director 安装使用默认的角色文件。

- scheduler_max_attempts

- 调度程序尝试部署实例的次数上限。此值必须大于或等于您期望一次部署的裸机节点数,以解决调度时的潜在争用情形。

- service_principal

- 使用该证书的服务的 Kerberos 主体。仅在您的 CA 需要 Kerberos 主体(如在 FreeIPA 中)时使用此参数。

- subnets

-

用于置备和内省的路由网络子网的列表。有关更多信息,请参阅 子网。默认值仅包括

ctlplane-subnet子网。 - templates

- 要覆盖的 heat 模板文件。

- undercloud_admin_host

-

通过 SSL/TLS 为 director Admin API 端点定义的 IP 地址或主机名。director 配置将 IP 地址作为路由的 IP 地址附加到 director 软件网桥,其使用

/32子网掩码。 - undercloud_debug

-

把 undercloud 服务的日志级别设置为

DEBUG。把值设为true来启用它。 - undercloud_enable_selinux

-

在部署期间启用或禁用 SELinux。除非调试问题,否则强烈建议保留此值设为

true。 - undercloud_hostname

- 定义 undercloud 的完全限定主机名。如果设置,undercloud 安装将配置所有系统主机名设置。如果保留未设置,undercloud 将使用当前的主机名,但用户必须相应地配置所有主机名设置。

- undercloud_log_file

-

用于存储 undercloud 安装/升级日志的日志文件的路径。默认情况下,日志文件是主目录中的

install-undercloud.log。例如,/home/stack/install-undercloud.log。 - undercloud_nameservers

- 用于 undercloud 主机名解析的 DNS 名称服务器列表。

- undercloud_ntp_servers

- 帮助同步 undercloud 日期和时间的网络时间协议服务器列表。

- undercloud_public_host

-

通过 SSL/TLS 为 director Public API 端点定义的 IP 地址或主机名。director 配置将 IP 地址作为路由的 IP 地址附加到 director 软件网桥,其使用

/32子网掩码。 - undercloud_service_certificate

- 用于 OpenStack SSL/TLS 通信的证书的位置和文件名。理想的情况是从一个信任的证书认证机构获得这个证书。否则,生成自己的自签名证书。

- undercloud_timezone

- undercloud 的主机时区。如果未指定时区,director 将使用现有时区配置。

- undercloud_update_packages

- 定义是否在安装 undercloud 期间更新软件包。

子网

每个置备子网在 undercloud.conf 文件中都有一个对应的同名部分。例如,要创建称为 ctlplane-subnet 的子网,在 undercloud.conf 文件中使用以下示例:

[ctlplane-subnet] cidr = 192.168.24.0/24 dhcp_start = 192.168.24.5 dhcp_end = 192.168.24.24 inspection_iprange = 192.168.24.100,192.168.24.120 gateway = 192.168.24.1 masquerade = true

您可以根据自身环境所需来指定相应数量的置备网络。

- gateway

-

overcloud 实例的网关。它是 undercloud 主机,会把网络流量转发到外部网络。保留其默认值

192.168.24.1,除非您需要 director 使用其他 IP 地址,或想直接使用外部网关。

director 配置还使用 sysctl 内核参数自动启用 IP 转发。

- cidr

-

director 用来管理 overcloud 实例的网络。这是 undercloud

neutron服务管理的 Provisioning 网络。保留其默认值192.168.24.0/24,除非您需要 Provisioning 网络使用其他子网。 - masquerade

-

定义是否伪装

cidr中定义的用于外部访问的网络。这为 Provisioning 网络提供了一定程度的网络地址转换 (NAT),使 Provisioning 网络能够通过 director 进行外部访问。 - dhcp_start; dhcp_end

- overcloud 节点 DHCP 分配范围的开始值和终止值。请确保此范围可以为节点提供足够的 IP 地址。

- dhcp_exclude

- DHCP 分配范围中排除的 IP 地址。

- host_routes

-

此网络上 Overcloud 实例的 Neutron 管理的子网的主机路由。这也为 undercloud 上的

local_subnet配置主机路由。

根据您的配置修改这些参数的值。完成后,请保存文件。

4.3. 使用环境文件配置 undercloud

您通过 undercloud.conf 文件配置 undercloud 的主要参数。您也可以配置特定于 undercloud 安装的 Heat 参数。您使用包含 Heat 参数的环境文件完成此操作。

步骤

-

在

/home/stack/templates/custom-undercloud-params.yaml上创建环境文件。 编辑此文件并包括您的 Heat 参数。以下示例显示如何为某些 OpenStack Platform 服务启用调试:

parameter_defaults: Debug: True

完成后保存此文件。

编辑

undercloud.conf文件,找到custom_env_files参数。编辑此参数以指向环境文件:custom_env_files = /home/stack/templates/custom-undercloud-params.yaml

注意您可以使用逗号分隔列表指定多个环境文件。

director 安装在下次安装或升级 undercloud 的操作过程中包括此环境文件。

4.4. 用于 undercloud 配置的常见 Heat 参数

下表显示您可能在自定义环境文件中为 undercloud 设置的一些常见 Heat 参数。

| 参数 | 描述 |

|---|---|

|

|

设置 undercloud |

|

|

设置 undercloud |

|

| 启用调试模式。 |

在自定义环境文件的 parameter_defaults 部分下设置这些参数:

parameter_defaults: Debug: True AdminPassword: "myp@ssw0rd!" AdminEmail: "admin@example.com"

4.5. 在 undercloud 上配置 hieradata

您可以通过在 director 上配置 Puppet hieradata,为可用 undercloud.conf 参数之外的服务提供自定义配置。执行以下步骤以使用此功能。

步骤

-

创建一个 hieradata 覆盖文件,例如

/home/stack/hieradata.yaml。 将自定义的 hieradata 添加到该文件。例如,添加以下内容,将 Compute (nova) 服务参数

force_raw_images从默认值“True”改为“False”:nova::compute::force_raw_images: False

如果没有为您要设置的参数实施 Puppet,则使用以下方法配置该参数:

nova::config::nova_config: DEFAULT/<parameter_name>: value: <parameter_value>例如:

nova::config::nova_config: DEFAULT/network_allocate_retries: value: 20 ironic/serial_console_state_timeout: value: 15将

hieradata_override参数设置为undercloud.conf中的 hieradata 文件的路径:hieradata_override = /home/stack/hieradata.yaml

4.6. 安装 director

完成以下步骤以安装 director 并执行一些基本安装后任务。

步骤

运行以下命令,以在 undercloud 上安装 director:

[stack@director ~]$ openstack undercloud install

这会启动 director 的配置脚本。director 安装附加软件包并根据

undercloud.conf中的配置来配置其服务。这个脚本会需要一些时间来完成。完成后,此脚本会生成两个文件:

-

undercloud-passwords.conf- director 服务的所有密码列表。 -

stackrc- 用来访问 director 命令行工具的一组初始变量。

-

此脚本还会自动启动所有的 OpenStack 平台服务容器。使用以下命令来检查已启用的容器:

[stack@director ~]$ sudo podman ps

运行以下命令初始化

stack用户来使用命令行工具:[stack@director ~]$ source ~/stackrc

提示信息现在指示,OpenStack 命令在对 undercloud 验证身份并执行命令;

(undercloud) [stack@director ~]$

director 的安装已完成。您现在可以使用 director 的命令行工具了。

4.7. 为 overcloud 节点获取镜像

director 需要几个磁盘镜像用于置备 overcloud 节点。这包括:

- 一个内省内核和 ramdisk - 用于通过 PXE 引导进行裸机系统内省。

- 一个实施内核和 ramdisk - 用于系统部署和实施。

- overcloud 内核、ramdisk 和完整镜像 - 写到节点硬盘中的基本 overcloud 系统。

以下操作过程旨在展示如何获取并安装这些镜像。

4.7.1. 单个 CPU 架构 overcloud

使用默认 CPU 架构 x86-64 部署 overcloud,需要这些镜像和过程。

步骤

查找

stackrc文件,以启用 director 的命令行工具:[stack@director ~]$ source ~/stackrc

安装

rhosp-director-images和rhosp-director-images-ipa软件包:(undercloud) [stack@director ~]$ sudo yum install rhosp-director-images rhosp-director-images-ipa

将镜像存档提取到

stack用户主页 (/home/stack/images) 中的images目录中:(undercloud) [stack@director ~]$ cd ~/images (undercloud) [stack@director images]$ for i in /usr/share/rhosp-director-images/overcloud-full-latest-15.0.tar /usr/share/rhosp-director-images/ironic-python-agent-latest-15.0.tar; do tar -xvf $i; done

把这些镜像导入到 director:

(undercloud) [stack@director images]$ openstack overcloud image upload --image-path /home/stack/images/

此脚本将以下镜像上传到 director:

-

bm-deploy-kernel -

bm-deploy-ramdisk -

overcloud-full -

overcloud-full-initrd -

overcloud-full-vmlinuz

另外,此脚本还会在 director 的 PXE 服务器上安装内省镜像。

-

检查这些镜像是否已成功上传:

(undercloud) [stack@director images]$ openstack image list +--------------------------------------+------------------------+ | ID | Name | +--------------------------------------+------------------------+ | 765a46af-4417-4592-91e5-a300ead3faf6 | bm-deploy-ramdisk | | 09b40e3d-0382-4925-a356-3a4b4f36b514 | bm-deploy-kernel | | ef793cd0-e65c-456a-a675-63cd57610bd5 | overcloud-full | | 9a51a6cb-4670-40de-b64b-b70f4dd44152 | overcloud-full-initrd | | 4f7e33f4-d617-47c1-b36f-cbe90f132e5d | overcloud-full-vmlinuz | +--------------------------------------+------------------------+

此列表不显示内省 PXE 镜像。director 将这些文件复制到

/var/lib/ironic/httpboot。(undercloud) [stack@director images]$ ls -l /var/lib/ironic/httpboot total 417296 -rwxr-xr-x. 1 root root 6639920 Jan 29 14:48 agent.kernel -rw-r--r--. 1 root root 420656424 Jan 29 14:48 agent.ramdisk -rw-r--r--. 1 42422 42422 758 Jan 29 14:29 boot.ipxe -rw-r--r--. 1 42422 42422 488 Jan 29 14:16 inspector.ipxe

4.7.2. 多个 CPU 架构 overcloud

部署 overcloud 以启用对附加 CPU 架构的支持需要这些镜像和操作。

以下过程在其示例中使用 ppc64le 镜像。

步骤

查找

stackrc文件,以启用 director 的命令行工具:[stack@director ~]$ source ~/stackrc

安装

rhosp-director-images-all软件包:(undercloud) [stack@director ~]$ sudo yum install rhosp-director-images-all

将存档解包到特定于架构的目录中,该目录位于

stack用户的主目录下的images目录 (/home/stack/images) 中:(undercloud) [stack@director ~]$ cd ~/images (undercloud) [stack@director images]$ for arch in x86_64 ppc64le ; do mkdir $arch ; done (undercloud) [stack@director images]$ for arch in x86_64 ppc64le ; do for i in /usr/share/rhosp-director-images/overcloud-full-latest-15.0-${arch}.tar /usr/share/rhosp-director-images/ironic-python-agent-latest-15.0-${arch}.tar ; do tar -C $arch -xf $i ; done ; done把这些镜像导入到 director:

(undercloud) [stack@director ~]$ cd ~/images (undercloud) [stack@director images]$ openstack overcloud image upload --image-path ~/images/ppc64le --architecture ppc64le --whole-disk --http-boot /tftpboot/ppc64le (undercloud) [stack@director images]$ openstack overcloud image upload --image-path ~/images/x86_64/ --http-boot /tftpboot

这会将下列镜像上传到 director:

-

bm-deploy-kernel -

bm-deploy-ramdisk -

overcloud-full -

overcloud-full-initrd -

overcloud-full-vmlinuz -

ppc64le-bm-deploy-kernel -

ppc64le-bm-deploy-ramdisk ppc64le-overcloud-full另外,此脚本还会在 director 的 PXE 服务器上安装内省镜像。

-

检查这些镜像是否已成功上传:

(undercloud) [stack@director images]$ openstack image list +--------------------------------------+---------------------------+--------+ | ID | Name | Status | +--------------------------------------+---------------------------+--------+ | 6d1005ba-ec82-473b-8e33-88aadb5b6792 | bm-deploy-kernel | active | | fb723b33-9f11-45f5-b25b-c008bf509290 | bm-deploy-ramdisk | active | | 6a6096ba-8f79-4343-b77c-4349f7b94960 | overcloud-full | active | | de2a1bde-9351-40d2-bbd7-7ce9d6eb50d8 | overcloud-full-initrd | active | | 67073533-dd2a-4a95-8e8b-0f108f031092 | overcloud-full-vmlinuz | active | | 69a9ffe5-06dc-4d81-a122-e5d56ed46c98 | ppc64le-bm-deploy-kernel | active | | 464dd809-f130-4055-9a39-cf6b63c1944e | ppc64le-bm-deploy-ramdisk | active | | f0fedcd0-3f28-4b44-9c88-619419007a03 | ppc64le-overcloud-full | active | +--------------------------------------+---------------------------+--------+

此列表不显示内省 PXE 镜像。director 会把这些文件复制到

/tftpboot。(undercloud) [stack@director images]$ ls -l /tftpboot /tftpboot/ppc64le/ /tftpboot: total 422624 -rwxr-xr-x. 1 root root 6385968 Aug 8 19:35 agent.kernel -rw-r--r--. 1 root root 425530268 Aug 8 19:35 agent.ramdisk -rwxr--r--. 1 ironic ironic 20832 Aug 8 02:08 chain.c32 -rwxr--r--. 1 ironic ironic 715584 Aug 8 02:06 ipxe.efi -rw-r--r--. 1 root root 22 Aug 8 02:06 map-file drwxr-xr-x. 2 ironic ironic 62 Aug 8 19:34 ppc64le -rwxr--r--. 1 ironic ironic 26826 Aug 8 02:08 pxelinux.0 drwxr-xr-x. 2 ironic ironic 21 Aug 8 02:06 pxelinux.cfg -rwxr--r--. 1 ironic ironic 69631 Aug 8 02:06 undionly.kpxe /tftpboot/ppc64le/: total 457204 -rwxr-xr-x. 1 root root 19858896 Aug 8 19:34 agent.kernel -rw-r--r--. 1 root root 448311235 Aug 8 19:34 agent.ramdisk -rw-r--r--. 1 ironic-inspector ironic-inspector 336 Aug 8 02:06 default

默认的 overcloud-full.qcow2 镜像是一种平面分区镜像。但是,您仍可以导入和使用完整的磁盘镜像。有关更多信息,请参阅 第 20 章 创建完整磁盘镜像。

4.8. 为 Control Plane 设置名称服务器

如果您希望 overcloud 解析外部主机名,如 cdn.redhat.com,建议您在 overcloud 节点上设置名称服务器。对于没有进行网络隔离的标准 overcloud,名称服务器会使用 undercloud 的控制平面子网来定义。完成以下过程为环境定义名称服务器。

步骤

查找

stackrc文件,以启用 director 的命令行工具:[stack@director ~]$ source ~/stackrc

为

ctlplane-subnet子网设置名称服务器:(undercloud) [stack@director images]$ openstack subnet set --dns-nameserver [nameserver1-ip] --dns-nameserver [nameserver2-ip] ctlplane-subnet

请为每一个名称服务器使用

--dns-nameserver选项。查看子网来验证名称解析服务器:

(undercloud) [stack@director images]$ openstack subnet show ctlplane-subnet +-------------------+-----------------------------------------------+ | Field | Value | +-------------------+-----------------------------------------------+ | ... | | | dns_nameservers | 8.8.8.8 | | ... | | +-------------------+-----------------------------------------------+

如果要将服务流量隔离到单独的网络,overcloud 节点将使用网络环境配置文件中的 DnsServer 参数。

4.9. 更新 undercloud 配置

未来,您可能必须更改 undercloud 配置以适合新的需求。要在安装后更改 undercloud 配置,请编辑相关配置文件并重新运行 openstack undercloud install 命令。

步骤

修改 undercloud 配置文件。例如,编辑

undercloud.conf文件并将idrac硬件类型添加到已启用硬件类型列表中:enabled_hardware_types = ipmi,redfish,idrac

运行

openstack undercloud install命令以使用新更改刷新 undercloud:[stack@director ~]$ openstack undercloud install

等待命令运行完成。

初始化

stack用户以使用命令行工具:[stack@director ~]$ source ~/stackrc

提示现在指示 OpenStack 命令对 undercloud 进行验证并执行:

(undercloud) [stack@director ~]$

确认 director 已应用新配置。在此示例中,检查已启用硬件类型列表:

(undercloud) [stack@director ~]$ openstack baremetal driver list +---------------------+----------------+ | Supported driver(s) | Active host(s) | +---------------------+----------------+ | idrac | unused | | ipmi | unused | | redfish | unused | +---------------------+----------------+

undercloud 重新配置完成。

4.10. Undercloud 容器registry

Red Hat Enterprise Linux 8 不再包括 docker-distribution 软件包,该软件包安装了 Docker Registry v2。为了保持兼容性和相同的功能级别,director 安装使用称为 image-serve 的 vhost 创建 Apache Web 服务器以提供 registry。该 registry 也使用禁用了 SSL 的端口 8787/TCP。基于 Apache 的 registry 未容器化,这意味着您要运行以下命令以重启 registry:

您可以在以下位置找到容器 registry 日志:

- /var/log/httpd/image_serve_access.log

- /var/log/httpd/image_serve_error.log。

$ sudo systemctl restart httpd

镜像内容来自 /var/lib/image-serve。此位置使用特定目录布局和 apache 配置来实施 registry REST API 的拉取功能。

基于 Apache 的 registry 是只读容器 registry,不支持 podman push 或 buildah push 命令。这意味着 registry 不允许您推送非 director 和非 OpenStack Platform 容器。但是,您可以使用 director 的容器准备工作流程修改 OpenStack Platform 镜像,该工作流程使用 ContainerImagePrepare 参数。

4.11. 后续步骤

undercloud 的配置到此结束。下一章将介绍基本的 overcloud 配置,包括注册节点和检查节点,并把它们标记为不同的节点角色。

部分 II. 基本的 Overcloud 部署

第 5 章 规划您的 overcloud

以下部分包含在规划 Red Hat OpenStack Platform 环境的各个方面的指导信息。这包括定义节点角色、规划您的网络拓扑结构和存储。

5.1. 节点角色

director 包括多个默认节点类型用于构建 overcloud。这些节点类型是:

- Controller

提供用于控制环境的关键服务。它包括仪表板服务 (horizon)、认证服务 (keystone)、镜像存储服务 (glance)、联网服务 (neutron)、编配服务 (heat) 以及高可用性服务。Red Hat OpenStack Platform 环境需要三个 Controller 节点以实现高可用生产级环境。

注意只有一个节点的环境仅用于测试目的,不应该用于生产环境。不支持由两个节点或由三个以上节点组成的环境。

- 计算(Compute)

- 用作虚拟机监控程序并包含在环境中运行虚拟机所需的处理能力的物理服务器。一个基本的 Red Hat OpenStack Platform 环境中需要最少一个 Compute 节点。

- Ceph 存储

- 提供 Red Hat Ceph Storage 的一个主机。额外的 Ceph Storage 主机可以在一个集群中扩展。这个部署角色是可选的。

- Swift Storage

- 提供外部对象存储 OpenStack Object Storage (swift) 服务的主机。这个部署角色是可选的。

下表包含一些不同 overcloud 的示例并为每个场景定义节点类型。

表 5.1. 节点部署

| Controller | 计算 | Ceph 存储 | Swift Storage | 总计 | |

| 小型 overcloud | 3 | 1 | - | - | 4 |

| 中型 overcloud | 3 | 3 | - | - | 6 |

| 带有额外对象存储的中型 overcloud | 3 | 3 | - | 3 | 9 |

| 带有 Ceph Storage 集群的中型 overcloud | 3 | 3 | 3 | - | 9 |

此外,还需思考是否要将各个服务划分成不同的自定义角色。有关可组合角色架构的更多信息,请参阅高级 Overcloud 自定义指南中的“可组合服务和自定义角色”。

5.2. Overcloud 网络

规划环境的网络拓扑和子网非常重要,它可以确保正确地映射角色和服务,以使其可以正确地相互通信。Red Hat OpenStack Platform 使用 Openstack Networking (neutron) 服务,此服务可自主运行,并可管理基于软件的网络、静态和浮动 IP 地址以及 DHCP。

默认情况下,director 配置节点以使用 Provisioning/Control Plane 获得连接。不过,可以将网络流量隔离到一系列的可组合网络,供您自定义和分配服务。

在典型的 Red Hat OpenStack Platform 安装中,网络类型的数量通常会超过物理网络链路的数量。为了可以把所有网络都连接到正确的主机,overcloud 使用 VLAN 标记(VLAN tagging)来为每个接口提供多个网络。大多数网络都是隔离的子网,但有些网络需要第 3 层网关来提供路由用于互联网访问或基础架构网络连接。如果使用 VLAN 来隔离网络流量类型,请使用支持 802.1Q 标准的交换机来提供 tagged VLAN。

我们推荐,即使在部署时使用了禁用隧道功能的 neutron VLAN,您最好仍然部署一个项目网络(利用 GRE 或 VXLAN 进行隧道连接)。这只需要在部署时进行一些微小的改变,便可为以后使用网络隧道功能(如用于 utility 网络或 virtualization 网络)留下选择余地。您仍然需要使用 VLAN 创建租户网络,但同时也可为特殊用途网络创建 VXLAN 隧道,而不需要消耗租户 VLAN。VXLAN 功能可以添加到带有租户 VLAN 的部署中,而租户 VLAN 却无法在不对系统运行造成干扰的情况下添加到现有的 overcloud 中。

director 还包括一组模板,以使用隔离的可组合网络配置 NIC。以下配置为默认配置:

- 单 NIC 配置 - 一个 NIC 在原生 VLAN 中用于 Provisioning 网络,并用于 tagged VLAN(使用子网处理不同的 overcloud 网络类型)。

- 绑定 NIC 配置 - 一个 NIC 在原生 VLAN 中用于 Provisioning 网络,tagged VLAN 绑定中的两个 NIC 用于不同的 overcloud 网络类型。

- 多 NIC 配置 - 每个 NIC 都使用一个子网来分别处理 overcloud 中不同的网络类型。

您也可以创建自己的模板来映射特定的 NIC 配置。

在考虑网络配置时,以下详细信息也很重要:

- 在 overcloud 创建过程中,在所有 overcloud 机器间使用同一个名称来代表 NIC。理想情况下,您应该在每个 overcloud 节点上对每个相关的网络都使用相同的 NIC 来避免混淆。例如,Provisioning 网络使用主(primary)NIC,OpenStack 服务使用从(secondary)NIC。

- 设置所有 overcloud 系统为从 Provisioning NIC 进行 PXE 引导,并禁用通过外部 NIC 和系统上的任何其他 NIC 进行 PXE 引导。另外,还需要确保 Provisioning NIC 在 PXE 引导设置中位于引导顺序的最上面(在硬盘和 CD/DVD 驱动器之前)。

- 所有 overcloud 裸机系统都需要一个受支持的电源管理接口,如智能平台管理接口(IPMI)。这将使得 director 能够控制每个节点的电源管理。

- 请记录下每个 overcloud 系统的以下信息:Provisioning NIC 的 MAC 地址、IPMI NIC 的 IP 地址、IPMI 用户名和 IPMI 密码。稍后设置 overcloud 节点时需要用到这些信息。

- 如果一个实例需要可以被外部互联网访问,则需要从公共网络中分配一个浮动 IP 地址,并把它和这个实例相关联。这个实例仍然会保留它的私人 IP,但网络数据可以通过 NAT 到达浮动 IP 地址。请注意,一个浮动 IP 地址只能分配给一个接口,而不能分配给多个私人 IP 地址。但是,浮动 IP 地址只会为一个租户预留以供使用,租户可以根据需要关联或取消关联一个特定的实例。此配置在外部互联网上公开您的基础架构。因此,您可能需要检查您是否遵循了适当的安全做法。

- 为了减少 Open vSwitch 中出现网络环路的风险,只能有一个接口或一个绑定作为给定网桥的成员。如果需要多个绑定或接口,可以配置多个网桥。

- 红帽建议使用 DNS 主机名解析,以便您的 overcloud 节点能够连接到外部服务,如 Red Hat Content Delivery Network 和网络时间服务器。

如果您使用 Red Hat Virtualization (RHV),则可以对 overcloud control plane 进行虚拟化。有关详细信息,请参阅创建虚拟化 control planes。

5.3. Overcloud 存储

在使用任何驱动程序的后端 cinder-volume 或后端类型的客户机实例上使用 LVM 会导致性能、卷可见性和可用性以及数据损坏问题。使用 LVM 过滤器可缓解这些问题。有关更多信息,请参阅存储指南中的第 2.1 节后端和 KCS 文章 3213311“在 cinder 卷上使用 LVM 会将数据公开给计算主机。”

director 包括面向 overcloud 环境的不同存储选项:

- Ceph Storage 节点

director 使用 Red Hat Ceph Storage 创建一组可扩展存储节点。overcloud 针对以下存储类型使用这些节点:

- 镜像 - Glance 管理虚拟机的镜像。镜像是不可变的,OpenStack 把镜像看做为二进制数据块,并根据它们的实际情况进行下载。OpenStack 将镜像视为二进制 blob 并相应地进行下载。您可以使用 glance 在 Ceph Block Device 中存储镜像。

- 卷 - Cinder 卷是块设备。OpenStack 使用卷来引导虚拟机,或把卷附加到运行的虚拟机上。OpenStack 使用 Cinder 服务管理卷。您可以使用 Cinder,通过镜像的写时复制(copy-on-write,简称 COW)克隆引导虚拟机。

- 文件系统 - Manila 共享由文件系统来支持。OpenStack 用户使用 manila 服务来管理共享。您可以使用 manila 来管理由 CephFS 文件系统(数据保存在 Ceph Storage 节点上)支持的共享。

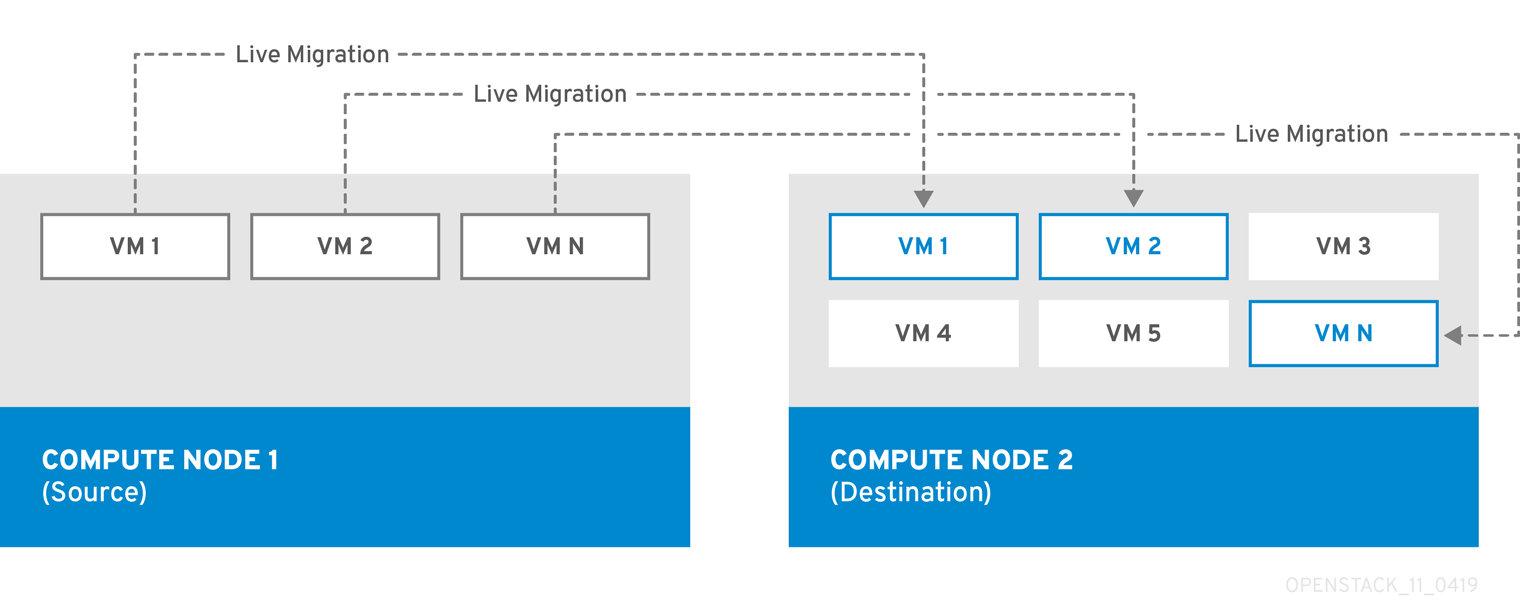

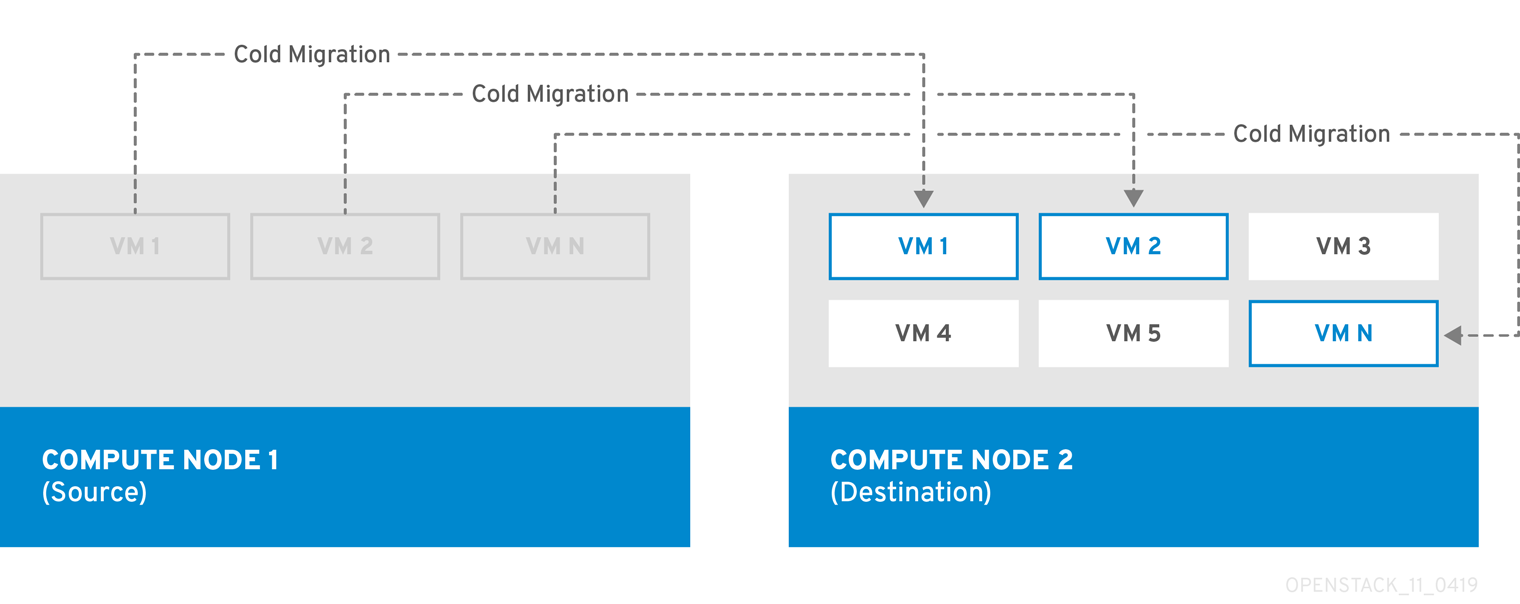

客户机磁盘 - 客户机磁盘就是客户机操作系统磁盘。默认情况下,当您使用 nova 引导虚拟机时,虚拟机磁盘会在虚拟机监控程序的文件系统上显示为一个文件(通常在

/var/lib/nova/instances/<uuid>/下)。Ceph 内的每一个虚拟机都无需使用 Cinder 即可引导。因此,您可以使用实时迁移过程轻松执行维护操作。此外,如果您的虚拟机监控程序出现问题,它还可以方便地触发nova evacuate,并在其他位置运行虚拟机。重要有关支持的镜像格式的信息,请参阅实例和镜像指南中的镜像服务章节。

有关更多信息,请参阅 Red Hat Ceph Storage 架构指南。

- Swift 存储节点

- director 会创建外部对象存储节点。当您需要扩展或替换 overcloud 环境中的控制器节点,同时需要在一个高可用性集群外保留对象存储时,这将非常有用。

5.4. Overcloud 安全性

OpenStack 平台环境的安全性在一定程度上取决于网络的安全性。遵循网络环境中的良好安全原则,确保正确控制网络访问:

- 使用网络分段缓解网络移动并隔离敏感数据。扁平网络的安全性要低得多。

- 限制对服务和端口的访问。

- 强制执行正确的防火墙规则并使用密码。

- 启用 SELinux。

有关保护系统安全的详细信息,请参阅以下红帽指南:

- Red Hat Enterprise Linux 8 的安全加固

- 对 Red Hat Enterprise Linux 8 使用 SELinux

5.5. Overcloud 高可用性

要部署高度可用的 overcloud,director 将配置多个 Controller、Compute 和 Storage 节点,并以单一集群的形式协同工作。出现节点故障时,根据故障的节点来触发自动隔离和重新生成流程。有关 overcloud 高可用性架构和服务的信息,请参阅了解 Red Hat OpenStack Platform 高可用性。

您也可以通过 director 为 Compute 实例配置高可用性 (Instance HA)。使用此高可用性机制,可在节点出现故障时在 Compute 节点上自动清空并重新生成实例。对 Instance HA 的要求与一般的 overcloud 要求相同,但必须执行一些附加步骤以准备好环境进行部署。有关 Instance HA 的工作原理和安装说明的信息,请参阅 Compute 实例的高可用性指南。

5.6. Controller 节点要求

Controller 节点在 Red Hat OpenStack Platform 环境中托管核心服务,如 Horizon 控制面板、后端数据库服务器、Keystone 身份验证和高可用性服务。

- 处理器

- 支持 Intel 64 或 AMD64 CPU 扩展的 64 位 x86 处理器。

- 内存

最小内存为 32 GB。不过,建议根据 vCPU 数量(CPU 内核数乘以超线程值)来决定内存大小。使用以下计算确定 RAM 要求:

控制器 RAM 最小值计算:

- 每个 vCPU 使用 1.5 GB 内存。例如,拥有 48 个 vCPU 的计算机应当具有 72 GB RAM。

控制器 RAM 建议值计算:

- 每个 vCPU 使用 3 GB 内存。例如,拥有 48 个 vCPU 的计算机应当具有 144 GB RAM。

有关衡量内存要求的更多信息,请参阅红帽客户门户网站上的“高可用性控制器的 Red Hat OpenStack Platform 硬件要求”。

- 磁盘存储和布局

如果 Object Storage 服务 (swift) 不在控制器节点上运行,则需要最小 40 GB 的存储。但是,Telemetry (

gnocchi) 和 Object Storage 服务都安装在 Controller 上,且二者均配置为使用根磁盘。这些默认值适合部署在商用硬件上构建的小型 overcloud。这些环境通常用于概念验证和测试环境。基于这些默认布局,只需最少的规划即可部署 overcloud,但只能提供很低的工作负载容量和性能。然而在企业环境中,这可能造成很大的瓶颈。这是因为 Telemetry 会不断地访问存储资源,导致磁盘 I/O 使用率很高,从而严重影响所有其他 Controller 服务的性能。在这种环境中,必须规划 overcloud 并进行相应的配置。

红帽为 Telemetry 和 Object Storage 提供了一些配置建议方案。有关详细信息,请参阅特定 Red Hat OpenStack Platform 服务的部署建议。

- 网络接口卡

- 最少两个 1 Gbps 网络接口卡。但在生产环境中,推荐最少使用两个网卡。

- 电源管理

- 每个 Controller 节点都需要在服务器的主板上有一个被支持的电源管理接口(如 IPMI)。

- 虚拟化支持

- 红帽仅在 Red Hat Virtualization 平台上支持虚拟化控制器节点。有关详细信息,请参阅 Virtualized control planes。

5.7. Compute 节点要求

Compute 节点负责运行虚拟机实例。Compute 节点必须支持硬件虚拟化。Compute 节点还必须有足够的内存和磁盘空间来支持其托管的虚拟机实例的要求。

- 处理器

- 支持带有 Intel 64 或 AMD64 CPU 扩展并启用了 Intel VT 硬件虚拟扩展的 64 位 x86 处理器。我们推荐所使用的处理器最少有 4 个内核。

- IBM POWER 8 处理器。

- 内存

- 至少 6 GB RAM。根据将要提供给虚拟机实例的内存大小,在此要求基础上增加额外的 RAM。

- 磁盘空间

- 最少具有 40GB 可用磁盘空间。

- 网络接口卡

- 最少一个 1 Gbps 网络接口卡。但在生产环境中,推荐最少使用两个网卡。

- 电源管理

- 每个 Compute 节点在服务器的主板上都要有一个受支持的电源管理接口(如智能平台管理接口 (IPMI) 功能)。

5.8. Ceph Storage 节点要求

Ceph Storage 节点负责在 Red Hat OpenStack Platform 环境中提供对象存储。

- 放置组

- Ceph 使用放置组大规模推动动态高效的对象跟踪。如果 OSD 出现故障或集群重新平衡,Ceph 可移动或复制放置组及其内容,这意味着 Ceph 集群可以有效地重新平衡并恢复。Director 创建的默认放置组计数并非始终最佳,因此一定要根据要求计算正确的放置组计数。您可以使用放置组计算器计算正确的计数:Placement Groups (PGs) per Pool Calculator

- 处理器

- 支持 Intel 64 或 AMD64 CPU 扩展的 64 位 x86 处理器。

- 内存

- 红帽通常建议每个 OSD 主机最少 16GB RAM,每个 OSD 守护进程增加 2 GB RAM。

- 磁盘配置

大小取决于您的存储需求。建议的 Red Hat Ceph Storage 节点配置在布局中至少需要三个或更多磁盘,类似以下示例:

-

/dev/sda- 根磁盘。director 把主 overcloud 镜像复制到该磁盘。这应当具有最少 40 GB 的可用磁盘空间。 -

/dev/sdb- journal 磁盘。这个磁盘被分为不同的分区来保存 Ceph OSD 的日志信息。例如,/dev/sdb1、/dev/sdb2、/dev/sdb3等。journal 磁盘通常需要是一个固态磁盘(SSD)来保证系统的性能。 /dev/sdc和后续 - OSD 磁盘。可以根据您的存储需要使用多个磁盘。注意Red Hat OpenStack Platform director 使用

ceph-ansible,不支持在 Ceph Storage 节点的根磁盘上安装 OSD。这意味着所支持的每个 Ceph Storage 节点需要至少两个或更多磁盘。

-

- 网络接口卡

- 最少一个 1 Gbps 网络接口卡。但在生产环境中,推荐最少使用两个网卡。额外的网卡可以组成绑定接口,或处理标记的 VLAN 网络(tagged VLAN)流量。 推荐为存储节点使用10 Gbps 接口,特别是所创建的 OpenStack 平台环境需要处理大量网络数据时。

- 电源管理

- 每个 Controller 节点都需要在服务器的主板上有一个被支持的电源管理接口(如 IPMI)。

有关使用 Ceph Storage 集群安装 overcloud 的更多信息,请参阅使用容器化 Red Hat Ceph 部署 Overcloud 指南。

5.9. Object Storage 节点要求

Object Storage 节点提供 overcloud 的对象存储层。Object Storage 代理安装在控制器节点上。存储层需要每个节点有多个磁盘的裸机节点。

- 处理器

- 支持 Intel 64 或 AMD64 CPU 扩展的 64 位 x86 处理器。

- 内存

- 内存要求取决于存储空间大小。理想状态下,每 1TB 硬盘空间需要至少 1GB 内存。要获得最佳性能,建议每 1 TB 硬盘空间使用 2 GB,特别是用于文件小于 100GB 的工作负载。

- 磁盘空间

存储要求取决于工作负载需要的容量。建议使用 SSD 驱动器来存储帐户和容器数据。帐户和容器数据与对象的容量比约为 1%。例如,对于每 100TB 硬盘容量,请提供 1TB 容量来存储帐户和容器数据。

不过,这还取决于所存储数据的类型。如果主要用于存储小对象,则提供更多 SSD 空间。而对于大对象(视频和备份等),可提供较少的 SSD 空间。

- 磁盘配置

建议的节点配置需要类似以下示例的磁盘布局:

-

/dev/sda- 根磁盘。director 把主 overcloud 镜像复制到该磁盘。 -

/dev/sdb- 用于帐户数据。 -

/dev/sdc- 用于容器数据。 -

/dev/sdd及后续 - 对象服务器磁盘。可以根据您的存储需要使用多个磁盘。

-

- 网络接口卡

- 最少两个 1 Gbps 网络接口卡。但在生产环境中,推荐最少使用两个网卡。

- 电源管理

- 每个 Controller 节点都需要在服务器的主板上有一个被支持的电源管理接口(如 IPMI)。

5.10. overcloud 软件仓库

您必须启用以下软件仓库以安装和配置 overcloud。

核心软件仓库

下表列出了用于安装 overcloud 的核心软件仓库。

| 名称 | 软件仓库 | 描述 |

|---|---|---|

| Red Hat Enterprise Linux 8 for x86_64 - BaseOS (RPMs) |

| x86_64 系统的基本操作系统仓库。 |

| Red Hat Enterprise Linux 8 for x86_64 - AppStream (RPMs) |

| 包括 Red Hat OpenStack Platform 的依赖软件包。 |

| Red Hat Enterprise Linux 8 for x86_64 - High Availability (RPMs) |

| Red Hat Enterprise Linux 的高可用性工具。用于 Controller 节点的高可用性功能。 |

| Red Hat Ansible Engine 2.8 for RHEL 8 x86_64 (RPMs) |

| 适用于 Red Hat Enterprise Linux 的 Ansible Engine。用于提供最新版本的 Ansible。 |

| Advanced Virtualization for RHEL 8 x86_64 (RPMs) |

| 为 OpenStack Platform 提供虚拟化软件包。 |

| Red Hat Satellite Tools for RHEL 8 Server RPMs x86_64 |

| 管理使用 Red Hat Satellite 6 的主机的工具。 |

| Red Hat OpenStack Platform 15 for RHEL 8 (RPMs) |

| Red Hat OpenStack Platform 核心软件仓库。 |

Real Time 软件仓库

下表列出了 Real Time Compute (RTC) 功能的软件仓库。

| 名称 | 软件仓库 | 描述 |

|---|---|---|

| Red Hat Enterprise Linux 8 for x86_64 - Real Time (RPMs) |

|

Real Time KVM (RT-KVM) 的软件仓库。包含用于启用实时内核的软件包。应该为 RT-KVM 的所有目标 Compute 节点启用这个软件仓库。注意:您需要单独订阅 |

| Red Hat Enterprise Linux 8 for x86_64 - Real Time for NFV (RPMs) |

|

适用于 NFV 的实时 KVM (RT-KVM) 的软件仓库。包含用于启用实时内核的软件包。应对以 RT-KVM 为目标的所有 NFV Compute 节点启用此软件仓库。注意:您需要单独订阅 |

IBM POWER 软件仓库

下表列出了用于 Openstack Platform on POWER PC 架构的软件仓库。使用这些软件仓库来替代核心软件仓库中的同等库。

| 名称 | 软件仓库 | 描述 |

|---|---|---|

| Red Hat Enterprise Linux for IBM Power, little endian - BaseOS (RPMs) |

| ppc64le 系统的基本操作系统软件仓库。 |

| Red Hat Enterprise Linux 8 for IBM Power, little endian - AppStream (RPMs) |

| 包括 Red Hat OpenStack Platform 的依赖软件包。 |

| Red Hat Enterprise Linux 8 for IBM Power, little endian - High Availability (RPMs) |

| Red Hat Enterprise Linux 的高可用性工具。用于 Controller 节点的高可用性功能。 |

| Red Hat Ansible Engine 2.8 for RHEL 8 IBM Power, little endian (RPMs) |

| 适用于 Red Hat Enterprise Linux 的 Ansible Engine。用于提供最新版本的 Ansible。 |

| Red Hat OpenStack Platform 15 for RHEL 8 (RPMs) |

| 用于 ppc64le 系统的 Red Hat OpenStack Platform 核心软件仓库。 |

第 6 章 使用 CLI 工具配置基本的 overcloud

本章包含使用 CLI 工具部署 OpenStack Platform 环境的基本配置过程。overcloud 基本配置中不含任何自定义功能。但是,您可以在此基本 overcloud 中添加高级配置选项并使用高级 Overcloud 自定义指南中的说明进行自定义,以符合您的规格。

6.1. 为 overcloud 注册节点

director 需要一个节点定义模板,这个模板由您手动创建。此模板使用 JSON 或 YAML 格式,并包含节点的硬件和电源管理详细信息。

步骤

创建列出节点的模板。使用以下 JSON 和 YAML 模板示例了解如何创建节点定义模板的结构:

示例 JSON 模板

{ "nodes":[ { "mac":[ "bb:bb:bb:bb:bb:bb" ], "name":"node01", "cpu":"4", "memory":"6144", "disk":"40", "arch":"x86_64", "pm_type":"ipmi", "pm_user":"admin", "pm_password":"p@55w0rd!", "pm_addr":"192.168.24.205" }, { "mac":[ "cc:cc:cc:cc:cc:cc" ], "name":"node02", "cpu":"4", "memory":"6144", "disk":"40", "arch":"x86_64", "pm_type":"ipmi", "pm_user":"admin", "pm_password":"p@55w0rd!", "pm_addr":"192.168.24.206" } ] }示例 YAML 模板

nodes: - mac: - "bb:bb:bb:bb:bb:bb" name: "node01" cpu: 4 memory: 6144 disk: 40 arch: "x86_64" pm_type: "ipmi" pm_user: "admin" pm_password: "p@55w0rd!" pm_addr: "192.168.24.205" - mac: - cc:cc:cc:cc:cc:cc name: "node02" cpu: 4 memory: 6144 disk: 40 arch: "x86_64" pm_type: "ipmi" pm_user: "admin" pm_password: "p@55w0rd!" pm_addr: "192.168.24.206"此模板包含以下属性:

- name

- 节点的逻辑名称。

- pm_type

要使用的电源管理驱动程序。此示例使用 IPMI 驱动程序 (

ipmi)。注意IPMI 是首选的受支持电源管理驱动程序。有关更多支持的电源管理类型及其选项,请参阅 附录 A, 电源管理驱动。如果这些电源管理驱动程序不能正常工作,请将 IPMI 用于电源管理。

- pm_user; pm_password

- IPMI 的用户名和密码。

- pm_addr

- IPMI 设备的 IP 地址。

- pm_port(可选)

- 访问特定 IPMI 设备的端口。

- mac

- (可选)节点上网络接口的 MAC 地址列表。对于每个系统的 Provisioning NIC,只使用 MAC 地址。

- cpu

- 节点上的 CPU 数量。(可选)

- memory

- 以 MB 为单位的内存大小。(可选)

- disk

- 以 GB 为单位的硬盘的大小。(可选)

- arch

系统架构。 (可选)

重要在构建多架构云时,

arch键是必需的,用于区分使用x86_64和ppc64le架构的节点。

创建模板后,运行以下命令验证格式和语法:

(undercloud) $ openstack overcloud node import --validate-only ~/nodes.json

将文件保存到

stack用户的主目录 (/home/stack/nodes.json),然后运行以下命令将模板导入 director:$ source ~/stackrc (undercloud) $ openstack overcloud node import ~/nodes.json

此命令通过模板将每个节点注册到 director 中。

等待节点完成注册和配置。完成后,确认 director 已成功注册节点:

(undercloud) $ openstack baremetal node list

6.2. 检查节点的硬件

director 可以在每个节点上运行内省进程。此进程在每个节点上通过 PXE 启动内省代理。内省代理从节点收集硬件数据并将其送回 director。然后,director 将此内省数据存储在 director 上运行的 OpenStack Object Storage (swift) 服务中。director 将硬件信息用于不同的用途,如配置集标记、基准测试和手动根磁盘分配。

步骤

运行以下命令检查每个节点的属性:

(undercloud) $ openstack overcloud node introspect --all-manageable --provide

-

--all-manageable选项仅内省处于受管理状态的节点。在此示例中,所有节点都处于受管理状态。 -

--provide选项会在内省后将所有节点重置为available状态。

-

在一个单独的终端窗口中运行以下命令来监测内省的进程:

(undercloud) $ sudo tail -f /var/log/containers/ironic-inspector/*.log

重要确保此进程完成运行。它可能需要 15 分钟来检查这些裸机节点。

-

内省完成后,所有节点都会变为

available状态。

6.3. 为节点添加标签以加入到配置集

注册并检查每个节点的硬件后,为节点添加标签以加入到特定配置集中。这些配置集标签将您的节点与类别相匹配,这会将类别分配给部署角色。以下示例显示 Controller 节点的角色、类别、配置集和节点间的关系:

| 类型 | 描述 |

|---|---|

| 角色 |

|

| 类型 |

|

| 配置集 |

|

| 节点 |

您也可以对单个节点应用 |

默认的配置文件类型 compute、control、swift-storage、ceph-storage 和 block-storage 会在 undercloud 的安装过程中创建,多数环境中可不经修改直接使用。

步骤

为了通过添加标签把节点标记为特定的配置集,把

profile选项添加到每个节点的properties/capabilities参数中。例如,把环境中的两个节点分别标记为使用 controller 配置集和 compute 配置集,使用以下命令:(undercloud) $ openstack baremetal node set --property capabilities='profile:compute,boot_option:local' 58c3d07e-24f2-48a7-bbb6-6843f0e8ee13 (undercloud) $ openstack baremetal node set --property capabilities='profile:control,boot_option:local' 1a4e30da-b6dc-499d-ba87-0bd8a3819bc0

其中的

profile:compute和profile:control选项会把节点标记为相关的配置集。这些命令还设置

boot_option:local参数,该参数用于定义每个节点的引导方式。在标记完节点后,检查分配的配置集或可能的配置集:

(undercloud) $ openstack overcloud profiles list

6.4. 设置 UEFI 引导模式

默认引导模式是传统 BIOS 模式。新式系统可能要求使用 UEFI 引导模式,而非传统 BIOS 模式。完成以下步骤以将引导模式更改为 UEFI 模式。

步骤

在

undercloud.conf文件中设置下列参数:ipxe_enabled = True inspection_enable_uefi = True

保存

undercloud.conf文件并运行 undercloud 安装:$ openstack undercloud install

等待安装脚本完成。

将每个注册节点的引导模式设置为

uefi。例如,要在capabilities属性中添加或替换现有的boot_mode参数,可运行以下命令:$ NODE=<NODE NAME OR ID> ; openstack baremetal node set --property capabilities="boot_mode:uefi,$(openstack baremetal node show $NODE -f json -c properties | jq -r .properties.capabilities | sed "s/boot_mode:[^,]*,//g")" $NODE

注意检查是否保留了

profile和boot_option功能。$ openstack baremetal node show r530-12 -f json -c properties | jq -r .properties.capabilities

将各个类型的引导模式设为

uefi:$ openstack flavor set --property capabilities:boot_mode='uefi' control

6.5. 定义根磁盘

如果节点使用多个磁盘,则 Director 在置备过程上必须识别根磁盘。例如,大多数 Ceph Storage 节点使用多个磁盘。默认情况下,director 在置备过程中将 overcloud 镜像写入根磁盘

您可以定义多个属性以帮助 director 识别根磁盘:

-

model(字符串):设备 ID。 -

vendor(字符串):设备厂商。 -

serial(字符串):磁盘序列号。 -

hctl(字符串):SCSI 的 Host:Channel:Target:Lun。 -

size(整数):设备的大小(以 GB 为单位)。 -

wwn(字符串):唯一的存储 ID。 -

wwn_with_extension(字符串):唯一存储 ID 附加厂商扩展名。 -

wwn_vendor_extension(字符串):唯一厂商存储标识符。 -

rotational(布尔值):旋转磁盘设备为 true (HDD),否则为 false (SSD)。 -

name(字符串):设备名称,例如:/dev/sdb1。

仅对具有持久名称的设备使用 name 属性。不要使用 name 来设置其他设备的根磁盘,因为此值在节点引导时可能会改变。

完成以下步骤以使用其序列号指定根设备。

步骤

从每个节点的硬件内省检查磁盘信息。运行以下命令以显示节点的磁盘信息:

(undercloud) $ openstack baremetal introspection data save 1a4e30da-b6dc-499d-ba87-0bd8a3819bc0 | jq ".inventory.disks"

例如,一个节点的数据可能会显示 3 个磁盘:

[ { "size": 299439751168, "rotational": true, "vendor": "DELL", "name": "/dev/sda", "wwn_vendor_extension": "0x1ea4dcc412a9632b", "wwn_with_extension": "0x61866da04f3807001ea4dcc412a9632b", "model": "PERC H330 Mini", "wwn": "0x61866da04f380700", "serial": "61866da04f3807001ea4dcc412a9632b" } { "size": 299439751168, "rotational": true, "vendor": "DELL", "name": "/dev/sdb", "wwn_vendor_extension": "0x1ea4e13c12e36ad6", "wwn_with_extension": "0x61866da04f380d001ea4e13c12e36ad6", "model": "PERC H330 Mini", "wwn": "0x61866da04f380d00", "serial": "61866da04f380d001ea4e13c12e36ad6" } { "size": 299439751168, "rotational": true, "vendor": "DELL", "name": "/dev/sdc", "wwn_vendor_extension": "0x1ea4e31e121cfb45", "wwn_with_extension": "0x61866da04f37fc001ea4e31e121cfb45", "model": "PERC H330 Mini", "wwn": "0x61866da04f37fc00", "serial": "61866da04f37fc001ea4e31e121cfb45" } ]本例演示了如何将根设备设置为磁盘 2,该磁盘的序列号为

61866da04f380d001ea4e13c12e36ad6。您必须更改为root_device参数才能定义节点:(undercloud) $ openstack baremetal node set --property root_device='{"serial": "61866da04f380d001ea4e13c12e36ad6"}' 1a4e30da-b6dc-499d-ba87-0bd8a3819bc0注意确保配置每个节点的 BIOS 以包括从您选择的根磁盘引导。建议的引导顺序是先网络引导,再根磁盘引导。

director 识别特定磁盘以用作根磁盘。运行 openstack overcloud deploy 命令时,director 置备 Overcloud 镜像并将其写入根磁盘。

6.6. 使用 overcloud-minimal 镜像

默认情况下,director 在置备过程中将 QCOW2 overcloud-full 镜像写入根磁盘。overcloud-full 镜像使用有效的红帽订阅。但是,如果您的节点上不需要任何其他 OpenStack 服务,并且您不想使用其中一个 Red Hat OpenStack Platform 订阅权利,则也可使用 overcloud-minimal 镜像。使用 overcloud-minimal 镜像选项以避免达到您购买的红帽订阅的极限。

要配置 director 使用 overcloud-minimal 镜像,创建包含以下镜像定义的环境文件:

parameter_defaults: <roleName>Image: overcloud-minimal

用角色名称替换 <roleName>,将 Image 附加到角色的名称上,然后将环境文件传递至部署命令。

例如,要对 Ceph storage 节点使用 overcloud-minimal 镜像,在 openstack overcloud deploy 命令中包括以下示例环境文件代码段:

parameter_defaults: CephStorageImage: overcloud-minimal

overcloud-minimal 镜像仅支持标准 Linux 网桥,不支持 OVS,因为 OVS 需要 OpenStack 订阅权利的 OpenStack 服务。

6.7. 创建特定于架构的角色

构建多架构云时,必须将所有架构特定的角色添加到 roles_data.yaml 文件中。以下示例包括 ComputePPC64LE 角色和默认角色:

openstack overcloud roles generate \

--roles-path /usr/share/openstack-tripleo-heat-templates/roles -o ~/templates/roles_data.yaml \

Controller Compute ComputePPC64LE BlockStorage ObjectStorage CephStorage创建自定义角色文件部分包含角色的相关信息。

6.8. 环境文件

undercloud 包括一组构成您的 overcloud 创建计划的 Heat 模板。您可以使用环境文件来自定义 overcloud 的各个方面,这些文件是 YAML 格式的文件,其内容可覆盖核心 Heat 模板集合中的参数和资源。您可以根据需要纳入多个环境文件。但是,环境文件的顺序非常重要,因为后续环境文件中定义的参数和资源更为优先。以下列表是环境文件顺序的示例:

- 节点数和每个角色的类别。包含此信息对于创建 overcloud 至关重要。

- 容器化 OpenStack 服务的容器镜像位置。

任何网络隔离文件,首先是 heat 模板集合中的初始化文件 (

environments/network-isolation.yaml),然后是您自定义的 NIC 配置文件,最后是任何额外的网络配置。有关更多信息,请参阅“高级 Overcloud 自定义”指南中的以下章节:- 使用外部负载均衡器时的所有外部负载平衡环境文件。有关更多信息,请参阅 Overcloud 的外部负载平衡。

- 任何存储环境文件,如 Ceph Storage、NFS、iSCSI 等。

- 任何用于红帽 CDN 或 Satellite 注册的环境文件。

- 任何其它自定义环境文件。

建议将自定义环境文件放在一个单独目录中,比如 templates 目录。

您可以使用高级 Overcloud 自定义指南为您的 overcloud 自定义高级功能。

一个基本的 overcloud 会使用本地 LVM 存储作为块存储,这种配置不受支持。建议您使用外部存储解决方案(如 Red Hat Ceph Storage)来实现块存储。

环境文件扩展名必须为 .yaml 或 .template,否则不会被视为自定义模板资源。

接下来的几个部分包含有关创建 overcloud 所需的一些环境文件的信息。

6.9. 创建定义节点数目和类型的环境文件

默认情况下,director 部署具有 1 个 Controller 节点和 1 个 Compute 节点的 overcloud,节点的类型是 baremetal。不过,这仅适用于概念验证部署。您可以通过指定不同的节点数目和类型来覆盖默认配置。对于小规模的生产环境,您可以考虑至少 3 个 Controller 节点和 3 个 Compute 节点,并分配特定类别以确保节点具有正确的资源规范。完成以下步骤以创建名为 node-info.yaml 的环境文件,用于存储节点计数和类别分配。

步骤

在

/home/stack/templates/目录中创建node-info.yaml文件:(undercloud) $ touch /home/stack/templates/node-info.yaml

编辑这个文件,使其包含您需要的节点数目和类型。此示例包含 3 个 Controller 节点和 3 个 Compute 节点:

parameter_defaults: OvercloudControllerFlavor: control OvercloudComputeFlavor: compute ControllerCount: 3 ComputeCount: 3

6.10. 创建 undercloud CA 信任的环境文件

如果您的 undercloud 使用 TLS,而证书颁发机构 (CA) 未获得公开信任,可将此 CA 用于 undercloud 操作的 SSL 端点加密。为确保其余部署可以访问 undercloud 端点,请将您的 overcloud 节点配置成信任 undercloud CA。

要使这种方法奏效,overcloud 节点必须有一个指向 undercloud 公共端点的网络路由。依赖于脊叶型网络的部署可能需要应用这种配置。

有两种自定义证书可用于 undercloud:

-

用户提供的证书 - 当您自行提供证书时,会应用此定义。证书可能来自于您自己的 CA,也可能是自签名的。这通过使用

undercloud_service_certificate选项来传递。在这种情况下,您必须信任自签名证书,或 CA(具体取决于您的部署)。 -

自动生成的证书 - 当您通过

certmonger生成使用自己的本地 CA 的证书时,会应用此定义。这使用undercloud.conf文件中的generate_service_certificate选项启用。在这种情况下,director 在/etc/pki/ca-trust/source/anchors/cm-local-ca.pem生成 CA 证书,并配置 undercloud 的 HAProxy 实例以使用服务器证书。将 CA 证书添加到inject-trust-anchor-hiera.yaml文件中以将其呈现给 OpenStack Platform。

本例中使用了位于 /home/stack/ca.crt.pem 的一个自签名证书。如果您使用自动生成的证书,请改为使用 /etc/pki/ca-trust/source/anchors/cm-local-ca.pem。

步骤

打开证书文件,仅复制证书部分。不要包括其密钥:

$ vi /home/stack/ca.crt.pem

您需要的证书部分与下方简写的示例类似:

-----BEGIN CERTIFICATE----- MIIDlTCCAn2gAwIBAgIJAOnPtx2hHEhrMA0GCSqGSIb3DQEBCwUAMGExCzAJBgNV BAYTAlVTMQswCQYDVQQIDAJOQzEQMA4GA1UEBwwHUmFsZWlnaDEQMA4GA1UECgwH UmVkIEhhdDELMAkGA1UECwwCUUUxFDASBgNVBAMMCzE5Mi4xNjguMC4yMB4XDTE3 -----END CERTIFICATE-----

创建一个名为

/home/stack/inject-trust-anchor-hiera.yaml的 YAML 文件,其包含下列内容以及您从 PEM 文件复制而来的证书:parameter_defaults: CAMap: ... undercloud-ca: content: | -----BEGIN CERTIFICATE----- MIIDlTCCAn2gAwIBAgIJAOnPtx2hHEhrMA0GCSqGSIb3DQEBCwUAMGExCzAJBgNV BAYTAlVTMQswCQYDVQQIDAJOQzEQMA4GA1UEBwwHUmFsZWlnaDEQMA4GA1UECgwH UmVkIEhhdDELMAkGA1UECwwCUUUxFDASBgNVBAMMCzE5Mi4xNjguMC4yMB4XDTE3 -----END CERTIFICATE-----注意证书字符串必须采用 PEM 格式。

在部署 overcloud 的过程中,CA 证书被复制到每个 overcloud 节点。因此,每个节点都会信任 undercloud 的 SSL 端点提供的加密。有关环境文件的更多信息,请参阅 第 6.13 节 “在 overcloud 部署中包括环境文件”。

6.11. 部署命令

创建 OpenStack 环境的最后一个阶段是,运行 openstack overcloud deploy 命令以创建 overcloud。在运行此命令前,您应当已经熟悉关键的选项,以及如何纳入自定义的环境文件。

请勿将 openstack overcloud deploy 作为后台进程运行。如果作为后台进程运行,overcloud 创建可能在部署过程中挂起。

6.12. 部署命令选项

下表列出 openstack overcloud deploy 命令的其他参数。

表 6.1. 部署命令选项

| 参数 | 描述 |

|---|---|

|

|

包括在部署过程中使用的 Heat 模板的目录。如果为空,命令会使用位于 |

|

| 创建或更新的栈的名称 |

|

| 部署超时时间(分钟) |

|

| hypervisor 使用的虚拟类型 |

|

|

网络时间协议 (NTP) 服务器用于同步时间。您也可以在以逗号分隔的列表中指定多个 NTP 服务器,例如: |

|

| 为环境变量 no_proxy 指定自定义值。 这个环境变量被用来在代理通讯中排除特定的主机名。 |

|

|

定义访问 overcloud 节点的 SSH 用户。SSH 访问通常使用 |

|

|

传递给 overcloud 部署的额外环境文件。您可以多次指定此选项。请注意,传递到 |

|

| 需要在部署中包括的环境文件所在的目录。部署命令以数字顺序,然后以字母顺序处理这些环境文件。 |

|

| overcloud 在创建过程中会执行一组部署前检查。如果部署前检查出现任何非严重错误,则此选项会退出创建。我们推荐使用此选项,因为任何错误都有可能造成部署失败。 |

|

| overcloud 在创建过程中会执行一组部署前检查。如果部署前检查出现任何非关键警告,则此选项会退出创建。 |

|

| 对 overcloud 进行验证检查,但不实际创建 overcloud。 |

|

| 跳过 overcloud 部署后配置。 |

|

| 强制进行 overcloud 部署后配置。 |

|

|

跳过生成 |

|

| 到带有选项和参数的 YAML 文件的路径。 |

|

| 把 overcloud 节点注册到客户门户或 Satellite 6。 |

|

|

overcloud 节点的注册方法。 |

|

| 用于注册的组织。 |

|

| 强制注册系统(即使已经注册过)。 |

|

|

注册 overcloud 节点的 Satellite 服务器的基本 URL。此参数需要使用 Satellite 的 HTTP URL 而不是 HTTPS URL。例如,使用 http://satellite.example.com 而不使用 https://satellite.example.com。overcloud 的创建过程会使用此 URL 来确定服务器是 Red Hat Satellite 5 还是 Red Hat Satellite 6 服务器。如果服务器是 Red Hat Satellite 6 服务器,则 overcloud 获取 |

|

| 用于注册的激活码。 |

运行以下命令查看完整选项列表:

(undercloud) $ openstack help overcloud deploy

某些命令行参数已过时或已弃用,它们的功能可以通过环境文件的 parameter_defaults 部分中所包含的 Heat 模板参数实现。下表将已弃用的参数与 Heat 模板中的等效参数对应了起来。

表 6.2. 将被弃用的 CLI 参数映射到 Heat 模板参数

| 参数 | 描述 | Heat 模板参数 |

|---|---|---|

|

| 扩展的 Controller 节点数量 |

|

|

| 扩展的 Compute 节点数量 |

|

|

| 扩展的 Ceph 节点数量 |

|

|

| 扩展的 Cinder 节点数量 |

|

|

| 扩展的 Swift 节点数量 |

|

|

| Controller 节点使用的 flavor |

|

|

| Compute 节点使用的 flavor |

|

|

| Ceph 节点使用的 flavor |

|

|

| Cinder 节点使用的 flavor |

|

|

| Swift 存储节点使用的 flavor |

|

|

| 定义在 neutron 插件中配置的平面网络。默认是 "datacentre",允许外部网络创建 |

|

|

| 在每个虚拟机管理器上创建的 Open vSwitch 网桥。默认是“br-ex”。通常,这不需要更改 |

|

|

| 要使用的逻辑网络到物理网桥的映射。默认是把主机上的外部网桥 (br-ex) 映射到一个物理名称 (datacentre)。您可以使用它作为默认的浮动网络 |

|

|

| 定义网络节点的 br-ex 中的网桥接口 |

|

|

| neutron 的租户网络类型 |

|

|

| Neutron 租户网络的隧道类型。使用逗号分隔的字符串可以指定多个值 |

|

|

| 可以用来进行租户网络分配的 GRE 隧道 ID 的范围 |

|

|

| 可以用来进行租户网络分配的 VXLAN VNI ID 范围 |

|

|

| 支持的 Neutron ML2 和 Open vSwitch VLAN 映射范围。默认是在 datacentre 物理网络中允许任何 VLAN |

|

|

| neutron 租户网络的机制驱动。默认值是 "openvswitch"。使用逗号分隔的字符串可以指定多个值 |

|

|

| 禁用隧道功能以在 Neutron 中使用 VLAN 分段网络或平面网络 | 无参数映射。 |

|

| overcloud 在创建过程中会执行一组部署前检查。在使用这个选项时,如果部署前检查出现任何严重错误,则会退出创建。我们推荐使用此选项,因为任何错误都有可能造成部署失败。 | 未进行参数映射 |

这些参数计划从未来的 Red Hat OpenStack Platform 版本中移除。

6.13. 在 overcloud 部署中包括环境文件

使用 -e 选项包括环境文件以自定义您的 overcloud。您可以根据需要纳入多个环境文件。但是,环境文件的顺序非常重要,因为后续环境文件中定义的参数和资源更为优先。以下列表是环境文件顺序的示例:

- 节点数和每个角色的类别。包含此信息对于创建 overcloud 至关重要。

- 容器化 OpenStack 服务的容器镜像位置。

任何网络隔离文件,首先是 heat 模板集合中的初始化文件 (

environments/network-isolation.yaml),然后是您自定义的 NIC 配置文件,最后是任何额外的网络配置。有关更多信息,请参阅“高级 Overcloud 自定义”指南中的以下章节:- 使用外部负载均衡器时的所有外部负载平衡环境文件。有关更多信息,请参阅 Overcloud 的外部负载平衡。

- 任何存储环境文件,如 Ceph Storage、NFS、iSCSI 等。

- 任何用于红帽 CDN 或 Satellite 注册的环境文件。

- 任何其它自定义环境文件。

使用 -e 选项添加的所有环境文件都会成为 overcloud 栈定义的一部分。

下例中的命令演示如何使用此场景中早前定义的环境文件来启动 overcloud 创建过程:

(undercloud) $ openstack overcloud deploy --templates \ -e /home/stack/templates/node-info.yaml\ -e /home/stack/containers-prepare-parameter.yaml \ -e /home/stack/inject-trust-anchor-hiera.yaml -r /home/stack/templates/roles_data.yaml \

这个命令包括以下额外选项:

- --templates

-

以

/usr/share/openstack-tripleo-heat-templates中的 Heat 模板集合为基础来创建 overcloud - -e /home/stack/templates/node-info.yaml

- 添加环境文件以定义每种角色有多少个节点以及使用哪些类型。

- -e /home/stack/containers-prepare-parameter.yaml

- 添加容器镜像准备环境文件。您在安装 undercloud 的过程中生成了此文件,可使用此文件创建 overcloud。

- -e /home/stack/inject-trust-anchor-hiera.yaml

- 添加用于在 undercloud 中安装自定义证书的环境文件。

- -r /home/stack/templates/roles_data.yaml

- (可选)如果使用自定义角色或启用多架构云,这是生成的角色数据。有关更多信息,请参阅 第 6.7 节 “创建特定于架构的角色”。

director 需要这些环境文件用于重新部署和部署后功能。没有正确包含这些文件可能会破坏您的 overcloud。

要在稍后阶段修改 overcloud 配置,请执行以下操作:

- 修改定制环境文件和 Heat 模板中的参数

-

使用相同的环境文件再次运行

openstack overcloud deploy命令

不要直接编辑 overcloud 的配置,因为在使用 director 对 overcloud 栈进行更新时,这种手动配置会被 director 的配置覆盖。

6.14. 在部署前验证 overcloud 配置

在执行 overcloud 部署操作前,先验证您的 Heat 模板和环境文件,确认是否存在任何错误。

步骤

overcloud 的 Heat 核心模板采用 Jinja2 格式。要验证您的模板,请使用以下命令呈现未采用 Jinja2 格式的版本:

$ cd /usr/share/openstack-tripleo-heat-templates $ ./tools/process-templates.py -o ~/overcloud-validation

使用下列命令来验证模板语法:

(undercloud) $ openstack orchestration template validate --show-nested \ --template ~/overcloud-validation/overcloud.yaml -e ~/overcloud-validation/overcloud-resource-registry-puppet.yaml \ -e [ENVIRONMENT FILE] \ -e [ENVIRONMENT FILE]

验证过程需要

overcloud-resource-registry-puppet.yaml环境文件包括针对于 overcloud 的资源。使用-e选项为这个命令添加其他额外的环境文件。此外,还需包含--show-nested选项,以解析来自嵌套模板的参数。- 验证命令识别模板中的任何语法错误。如果模板语法验证成功,该命令将返回生成的 overcloud 模板的预览。

6.15. Overcloud 部署输出

一旦 overcloud 创建完毕,director 会提供为配置 overcloud 而执行的 Ansible play 的总结:

PLAY RECAP ************************************************************* overcloud-compute-0 : ok=160 changed=67 unreachable=0 failed=0 overcloud-controller-0 : ok=210 changed=93 unreachable=0 failed=0 undercloud : ok=10 changed=7 unreachable=0 failed=0 Tuesday 15 October 2018 18:30:57 +1000 (0:00:00.107) 1:06:37.514 ****** ========================================================================

director 还会提供用于访问 overcloud 的详细信息。

Ansible passed. Overcloud configuration completed. Overcloud Endpoint: http://192.168.24.113:5000 Overcloud Horizon Dashboard URL: http://192.168.24.113:80/dashboard Overcloud rc file: /home/stack/overcloudrc Overcloud Deployed

6.16. 访问 overcloud

director 会生成脚本来配置和帮助认证 director 主机与 overcloud 的交互。director 将此文件保存为 stack 用户主目录的 overcloudrc 文件。运行以下命令来使用此文件:

(undercloud) $ source ~/overcloudrc

这将加载所需的环境变量,以便从 director 主机的 CLI 与 overcloud 交互。命令提示符的变化会显示当前状态:

(overcloud) $

要返回与 director 主机进行交互的状态,请运行以下命令:

(overcloud) $ source ~/stackrc (undercloud) $

overcloud 中的每个节点还包含 heat-admin 用户。stack 用户有到每个节点上的此用户的 SSH 访问权限。要通过 SSH 访问某一节点,可查找相关节点的 IP 地址:

(undercloud) $ openstack server list

使用 heat-admin 用户和节点的 IP 地址连接到节点:

(undercloud) $ ssh heat-admin@192.168.24.23

6.17. 后续步骤

使用命令行工具创建 overcloud 的步骤到此结束。有关创建后功能,请参阅 第 9 章 执行 overcloud 安装后任务。

第 7 章 使用预置备节点配置基本 overcloud

本章包含使用预置备节点配置 OpenStack Platform 环境的基本配置过程。这种情境与标准 overcloud 创建情境有所不同,具体体现在以下几个方面:

- 您可以使用外部工具配置节点,让 director 仅控制 overcloud 的配置。

- 您无需依赖 director 的配置方法,可直接使用节点。如果您想创建没有电源管理控制的 overcloud 或使用具有 DHCP/PXE 引导限制的网络,该方法很有用。

- director 不使用 OpenStack Compute (nova)、OpenStack Bare Metal (ironic) 或者 OpenStack Image (glance) 来管理节点。

-

预置备的节点可以使用不依赖于 QCOW2

overcloud-full镜像的自定义置备布局。

这种情境仅包括没有自定义功能的基本配置。但是,您可以在此基本 overcloud 中添加高级配置选项并使用高级 Overcloud 自定义指南中的说明进行自定义,以符合您的规格。

不支持在 overcloud 中组合预置备节点和 director 置备的节点。

7.1. 预置备节点要求

- 第 4 章 安装 director中创建的 director 节点。

- 一组作为节点的裸机。所需的节点数量由您需要创建的 overcloud 类型所决定。这些机器必须符合为每个节点类型设定的要求。这些节点需要 Red Hat Enterprise Linux 7.6 或更高版本作为主机操作系统安装。红帽建议使用最新的可用版本。

- 用于管理预置备节点的一个网络连接。本情境需要具备对节点的不间断 SSH 访问权限以进行编配代理配置。

Control Plane 网络的一个网络连接。这种网络具备两种主要情境:

将 Provisioning 网络用作 Control Plane,这种是默认情境。这个网络通常是从预置备节点到 director 的第 3 层 (L3) 可路由网络连接。本情境示例使用以下 IP 地址分配:

表 7.1. Provisioning 网络 IP 分配信息

节点名 IP 地址 Director

192.168.24.1

控制器 0

192.168.24.2

计算 0

192.168.24.3

- 使用单独的网络。如果 director 的 Provisioning 网络是私有非路由网络,则可从任何子网定义节点的 IP 地址,通过公共 API 端点与 director 通信。此情境有一些注意事项,本章稍后将在 第 7.6 节 “为预置备节点使用单独网络”中加以介绍。

- 本示例中的所有其他网络类型使用 Control Plane 网络来提供 OpenStack 服务。不过,您可以为其他网络流量类型创建额外的网络。

7.2. 在预置备节点上创建用户

使用预置备节点配置 overcloud 时,director 需要以 stack 用户身份对 overcloud 节点进行 SSH 访问。要创建 stack 用户,请完成以下步骤。

步骤

在每个 overcloud 节点上,创建

stack用户并在每个节点上设定密码。例如,在 Controller 节点上运行以下命令:[root@controller-0 ~]# useradd stack [root@controller-0 ~]# passwd stack # specify a password

进行以下操作以使这个用户使用

sudo时不需要输入密码:[root@controller-0 ~]# echo "stack ALL=(root) NOPASSWD:ALL" | tee -a /etc/sudoers.d/stack [root@controller-0 ~]# chmod 0440 /etc/sudoers.d/stack

在所有预置备节点上创建并配置

stack用户后,将stack用户的公共 SSH 密钥从 director 节点复制到每个 overcloud 节点。例如,要将 director 的公共 SSH 密钥复制到 Controller 节点,请运行以下命令:[stack@director ~]$ ssh-copy-id stack@192.168.24.2

7.3. 为预置备节点注册操作系统

每个节点需要具备访问红帽订阅的权限。在每个节点上完成以下步骤,将每个相应节点注册到 Red Hat Content Delivery Network 中。

步骤

运行注册命令,按照提示输入您的客户门户用户名和密码:

[root@controller-0 ~]# sudo subscription-manager register

查找 Red Hat OpenStack Platform 15 的权利池:

[root@controller-0 ~]# sudo subscription-manager list --available --all --matches="Red Hat OpenStack"

使用上一步中的池 ID 以附加 Red Hat OpenStack Platform 15 权利:

[root@controller-0 ~]# sudo subscription-manager attach --pool=pool_id

禁用所有默认软件仓库:

[root@controller-0 ~]# sudo subscription-manager repos --disable=*

启用所需的 Red Hat Enterprise Linux 软件仓库。

对于 x86_64 系统,请运行:

[root@controller-0 ~]# sudo subscription-manager repos --enable=rhel-8-for-x86_64-baseos-rpms --enable=rhel-8-for-x86_64-appstream-rpms --enable=rhel-8-for-x86_64-highavailability-rpms --enable=ansible-2.8-for-rhel-8-x86_64-rpms --enable=openstack-15-for-rhel-8-x86_64-rpms --enable=rhceph-4-osd-for-rhel-8-x86_64-rpms--enable=rhceph-4-mon-for-rhel-8-x86_64-rpms --enable=rhceph-4-tools-for-rhel-8-x86_64-rpms --enable=advanced-virt-for-rhel-8-x86_64-rpms

对于 POWER 系统,请运行:

[root@controller-0 ~]# sudo subscription-manager repos --enable=rhel-8-for-ppc64le-baseos-rpms --enable=rhel-8-for-ppc64le-appstream-rpms --enable=rhel-8-for-ppc64le-highavailability-rpms --enable=ansible-2.8-for-rhel-8-ppc64le-rpms --enable=openstack-15-for-rhel-8-ppc64le-rpms --enable=advanced-virt-for-rhel-8-ppc64le-rpms

重要仅启用列出的软件仓库。其他软件仓库可能导致软件包和软件冲突。请勿启用任何其他软件仓库。

更新您的系统,确保您具备最新的基础系统软件包:

[root@controller-0 ~]# sudo yum update -y [root@controller-0 ~]# sudo reboot

节点现在可供您的 overcloud 使用。

7.4. 配置对 director 的 SSL/TLS 访问权限

如果 director 使用 SSL/TLS,那么预置备节点需要用于签署 director 的 SSL/TLS 证书的证书授权机构文件。如果使用自己的证书颁发机构(CA),请在每个 overcloud 节点上执行以下操作。

步骤

-

将证书授权机构文件复制到各预置备节点上的

/etc/pki/ca-trust/source/anchors/目录中。 在每个 overcloud 节点上运行以下命令:

[root@controller-0 ~]# sudo update-ca-trust extract

这些步骤将确保 overcloud 节点可以通过 SSL/TLS 访问 director 的公共 API。

7.5. 配置 control plane 网络

预置备 overcloud 节点使用标准 HTTP 请求从 director 获取元数据。这表示所有 overcloud 节点都需要 L3 权限来访问以下之一:

-

Director 的 Control Plane 网络,这是在

undercloud.conf文件中使用network_cidr参数定义的子网。overcloud 节点需要对该子网的直接访问权限或对该子网的可路由访问权限。 -

director 的公共 API 端点,由

undercloud.conf文件中的undercloud_public_host参数指定。如果没有指向 Control Plane 的 L3 路由或希望使用 SSL/TLS 通信,则此选项可用。有关配置 overcloud 节点以使用公共 API 端点的更多信息,请参阅 第 7.6 节 “为预置备节点使用单独网络”。

Director 使用 Control Plane 网络管理和配置标准 overcloud。对于具有预置备节点的 overcloud,可能需要对您的网络配置进行修改以适应 director 和预置备节点之间的通信。

使用网络隔离

您可以使用网络隔离分组服务以使用特定网络,包括 Control Plane。高级 Overcloud 自定义指南中有多个网络隔离策略。您可以为 control plane 上的节点定义特定 IP 地址。有关隔离网络和创建可预测节点放置策略的更多信息,请参阅高级 Overcloud 自定义指南中的以下章节:

如果使用网络隔离,请确保您的 NIC 模板不包括用于 undercloud 访问的 NIC。这些模板可能会重新配置 NIC,这会导致在部署过程中出现连接和配置问题。

分配 IP 地址