监控和管理系统状态和性能

优化系统吞吐量、延迟和电源消耗

摘要

使开源包含更多

红帽致力于替换我们的代码、文档和 Web 属性中存在问题的语言。我们从这四个术语开始:master、slave、黑名单和白名单。由于此项工作十分艰巨,这些更改将在即将推出的几个发行版本中逐步实施。详情请查看 CTO Chris Wright 的信息。

对红帽文档提供反馈

我们感谢您对我们文档的反馈。让我们了解如何改进它。

通过 Jira 提交反馈(需要帐户)

- 登录到 Jira 网站。

- 点顶部导航栏中的 Create

- 在 Summary 字段中输入描述性标题。

- 在 Description 字段中输入您的改进建议。包括文档相关部分的链接。

- 点对话框底部的 Create。

第 1 章 TuneD 入门

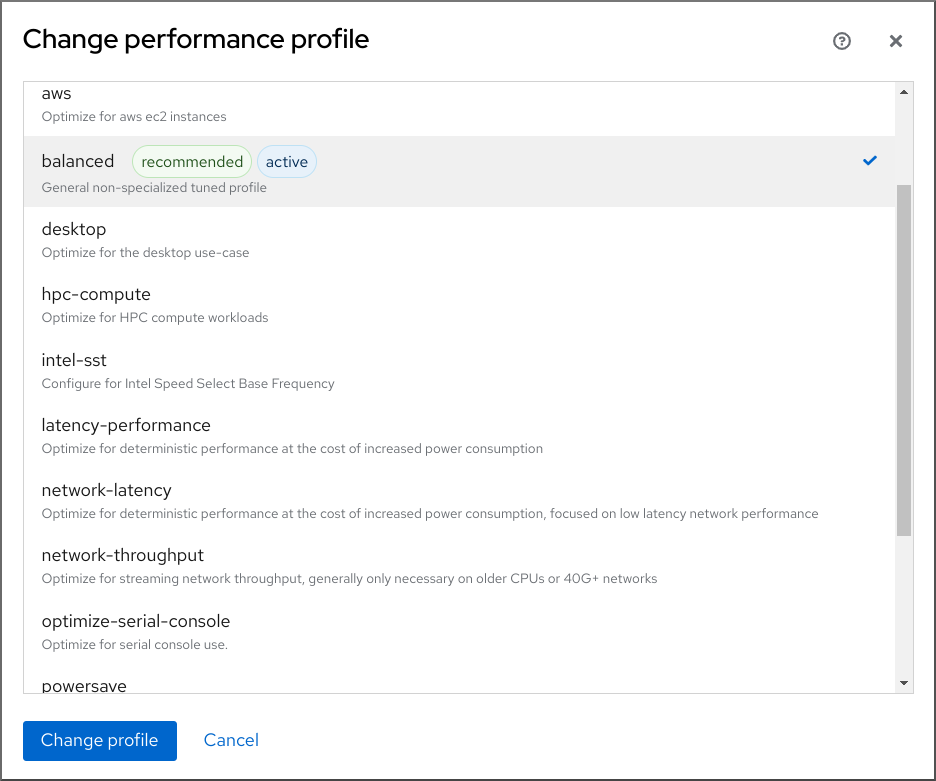

作为系统管理员,您可以使用 TuneD 应用程序来针对各种用例优化系统的性能配置集。

1.1. TuneD 的目的

TuneD 是监控您的系统并优化特定工作负载性能的服务。TuneD 的核心是 配置集 (profiles) ,它针对不同的用例调优您的系统。

TuneD 通过很多预定义的配置集发布,它们适用于以下用例:

- 高吞吐量

- 低延迟

- 保存电源

可以修改为每个配置集定义的规则,并自定义如何调整特定设备。当您切换到另一个配置集或取消激活 TuneD 时,对之前的配置集进行的所有更改都会恢复到其原始状态。

您还可以将 TuneD 配置为响应设备使用的变化,并调整设置以提高活跃设备的性能并减少不活跃设备的功耗。

1.2. 调优配置集

系统的详细分析可能会非常耗时。TuneD 为典型的用例提供了很多预定义的配置集。您还可以创建、修改和删除配置集。

TuneD 提供的配置集被分为以下几个类别:

- 节能配置集

- 性能提升配置集

性能提升配置集包括侧重于以下方面的配置集:

- 存储和网络的低延迟

- 存储和网络的高吞吐量

- 虚拟机性能

- 虚拟化主机性能

配置集配置的语法

tuned.conf 文件可以包含一个 [main] 部分,其他部分用于配置插件实例。但是,所有部分都是可选的。

以 hash 符号 (#) 开头的行是注释。

其他资源

-

tuned.conf (5)手册页.

1.3. 默认 TuneD 配置集

在安装过程中,将自动选择您的系统的最佳配置集。目前,会根据以下自定义规则选择默认配置集:

| 环境 | 默认配置集 | 目标 |

|---|---|---|

| Compute 节点 |

| 最佳吞吐量性能 |

| 虚拟机 |

|

最佳的性能。如果实现最佳性能并不是您最需要考虑的,可以将其改为 |

| 其他情况 |

| 平衡性能和能源消耗 |

其他资源

-

tuned.conf (5)手册页.

1.4. 合并的 TuneD 配置集

作为实验性功能,可以一次性选择更多配置集。tuned 将尝试在负载期间合并它们。

如果存在冲突,则最后指定的配置集的设置会优先使用。

例 1.1. 虚拟客户端中低功耗

以下示例优化了在虚拟机中运行的系统,以获得最佳性能,并同时将其调优以实现低功耗,低功耗比高性能有更高优先级:

# tuned-adm profile virtual-guest powersave

合并会在不检查生成的参数组合是否有意义的情况下自动进行。因此,该功能可能会以相反的方式调整一些参数,这么做可能会影响生产效率。例如,使用 throughput-performance 配置集针对高吞吐量设置磁盘,但当前通过 spindown-disk 配置集将磁盘旋转设置为低值。

其他资源

*tuned-adm man page。* tuned.conf (5) man page。

1.5. TuneD 配置集的位置

TuneD 配置集存储在以下目录中:

/usr/lib/tuned/-

特定于分发的配置文件存储在目录中。每个配置集都有自己的目录。该配置集由名为

tuned.conf的主配置文件以及其他文件(如帮助程序脚本)组成。 /etc/tuned/-

如果您需要自定义配置集,请将配置集目录复制到用于自定义配置集的目录中。如果同一名称有两个配置集,则使用位于

/etc/tuned/中的自定义配置集。

其他资源

-

tuned.conf (5)手册页.

1.6. RHEL 提供的调优配置集

以下是在 Red Hat Enterprise Linux 中安装 TuneD 的配置集列表。

更特定产品的或第三方的 TuneD 配置集也可能会存在。这些配置集通常由单独的 RPM 软件包提供。

balanced默认的节能配置文件。它在性能和功耗之间具有折衷。在可能的情况下尽可能使用自动扩展和自动调整。唯一缺陷是增加延迟。在当前的 TuneD 版本中,它启用了 CPU、磁盘、音频和视频插件,并激活了

conservativeCPU 调控器。如果支持,radeon_powersave选项使用dpm-balanced值,否则被设置为auto。它将

energy_performance_preference属性改为normal能源设置。它还将scaling_governor策略属性改为conservative或powersaveCPU 调控器。powersave用于最大节能性能的配置集。它可以对性能进行调整,从而最大程度降低实际功耗。在当前的 TuneD 发行版本中,它为 SATA 主机适配器启用 USB 自动挂起、WiFi 节能和 Aggresive Link Power Management (ALPM) 节能。它还为使用低折率的系统调度多核功耗,并激活

ondemand监管器。它启用了 AC97 音频节能,或根据您的系统,HDA-Intel 节能时间为 10 秒。如果您的系统包含启用了 KMS 支持的 Radeon 图形卡,配置集会将其配置为自动节能。在 ASUS Eee PC 上,启用了动态超级混合引擎。它将

energy_performance_preference属性改为powersave或powerenergy 设置。它还会将scaling_governor策略属性更改为ondemand或powersaveCPU 调控器。注意在某些情况下,与

powersave配置集相比,balanced配置集效率更高。请考虑存在定义的需要完成的工作,例如一个需要转码的视频文件。如果转码以全功率完成,则您的机器可能会消耗较少的能源,因为任务快速完成,因此计算机可以启动空闲,且自动缩减到非常有效的节能模式。另一方面,如果您把文件转码为节流的机器,则计算机在转码期间会消耗较少的电源,但进程会花费更长时间,且总体消耗的能源可能会更高。

这就是为什么

balanced配置文件通常是一个更好的选择。throughput-performance针对高吞吐量优化的服务器配置文件。它禁用节能机制并启用

sysctl设置,以提高磁盘和网络 IO 的吞吐量性能。CPU 调控器设置为performance。它将

energy_performance_preference和scaling_governor属性设置为performance配置集。accelerator-performance-

accelerator-performance配置集包含与throughput-performance配置集相同的调整。另外,它会将 CPU 锁定为低 C 状态,以便使延迟小于 100us。这提高了某些加速器的性能,如 GPU。 latency-performance为低延迟优化的服务器配置文件。它禁用节能机制并启用

sysctl设置来缩短延迟。CPU 调控器被设置为performance,CPU 被锁定到低 C 状态(按 PM QoS)。它将

energy_performance_preference和scaling_governor属性设置为performance配置集。network-latency低延迟网络调整的配置集。它基于

latency-performance配置集。它还禁用透明大内存页和 NUMA 平衡,并调整其他一些与网络相关的sysctl参数。它继承

latency-performance配置集,该配置集将power_performance_preference和scaling_governor属性更改为performance配置集。hpc-compute-

针对高性能计算而优化的配置集。它基于

latency-performance配置集。 network-throughput用于吞吐量网络调优的配置集。它基于

throughput-performance配置集。此外,它还增加了内核网络缓冲区。它继承

latency-performance或throughput-performance配置集,并将energy_performance_preference和scaling_governor属性改为performance配置集。virtual-guest为 Red Hat Enterprise Linux 9 虚拟机和 VMWare 虚拟机设计的配置集基于

throughput-performance配置集(除其他任务)减少了虚拟内存的交换性并增加磁盘预读值。它不会禁用磁盘障碍。它继承

throughput-performance配置集,该配置集将energy_performance_preference和scaling_governor属性更改为performance配置集。virtual-host基于

throughput-performance配置集(除其他任务)为虚拟主机设计的配置集降低了虚拟内存交换,增加磁盘预读值,并启用更主动的脏页面回写值。它继承

throughput-performance配置集,该配置集将energy_performance_preference和scaling_governor属性更改为performance配置集。oracle-

根据

throughput-performance配置集,为 Oracle 数据库负载进行了优化。它还禁用透明大内存页,并修改其他与性能相关的内核参数。这个配置集由tuned-profiles-oracle软件包提供。 desktop-

根据

balanced配置文件,为桌面进行了优化的配置集。此外,它还启用了调度程序自动组以更好地响应交互式应用程序。 optimize-serial-console通过减少 printk 值,将 I/O 活动微调到串行控制台的配置集。这应该使串行控制台更快响应。此配置集用作其他配置集的覆盖。例如:

# tuned-adm profile throughput-performance optimize-serial-console

mssql-

为 Microsoft SQL Server 提供的配置集。它基于

throughput-performance配置集。 intel-sst为带有用户定义的 Intel Speed Select Technology 配置的系统进行优化的配置集。此配置集用作其他配置集的覆盖。例如:

# tuned-adm profile cpu-partitioning intel-sst

1.7. TuneD cpu-partitioning 配置集

要为对延迟敏感的工作负载调整 Red Hat Enterprise Linux 9,红帽建议使用 cpu-partitioning TuneD 配置集。

在 Red Hat Enterprise Linux 9 之前,低延迟 Red Hat 文档描述了实现低延迟调整所需的大量低级别步骤。在 Red Hat Enterprise Linux 9 中,您可以使用 cpu-partitioning TuneD 配置集更有效地执行低延迟性能优化。根据个人低延迟应用程序的要求,此配置集可轻松自定义。

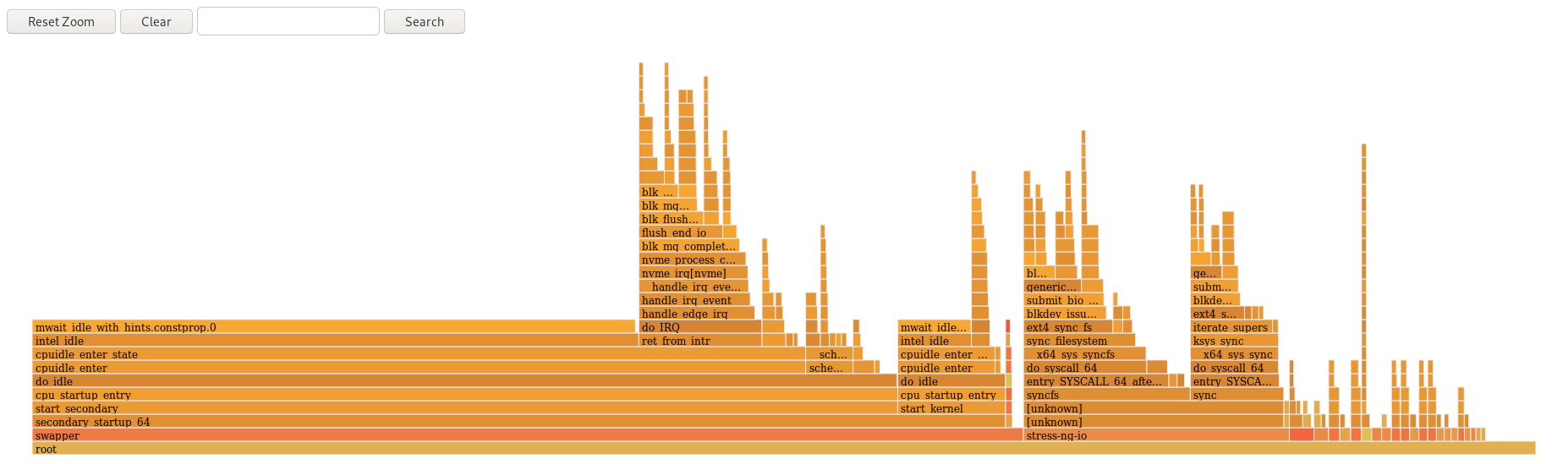

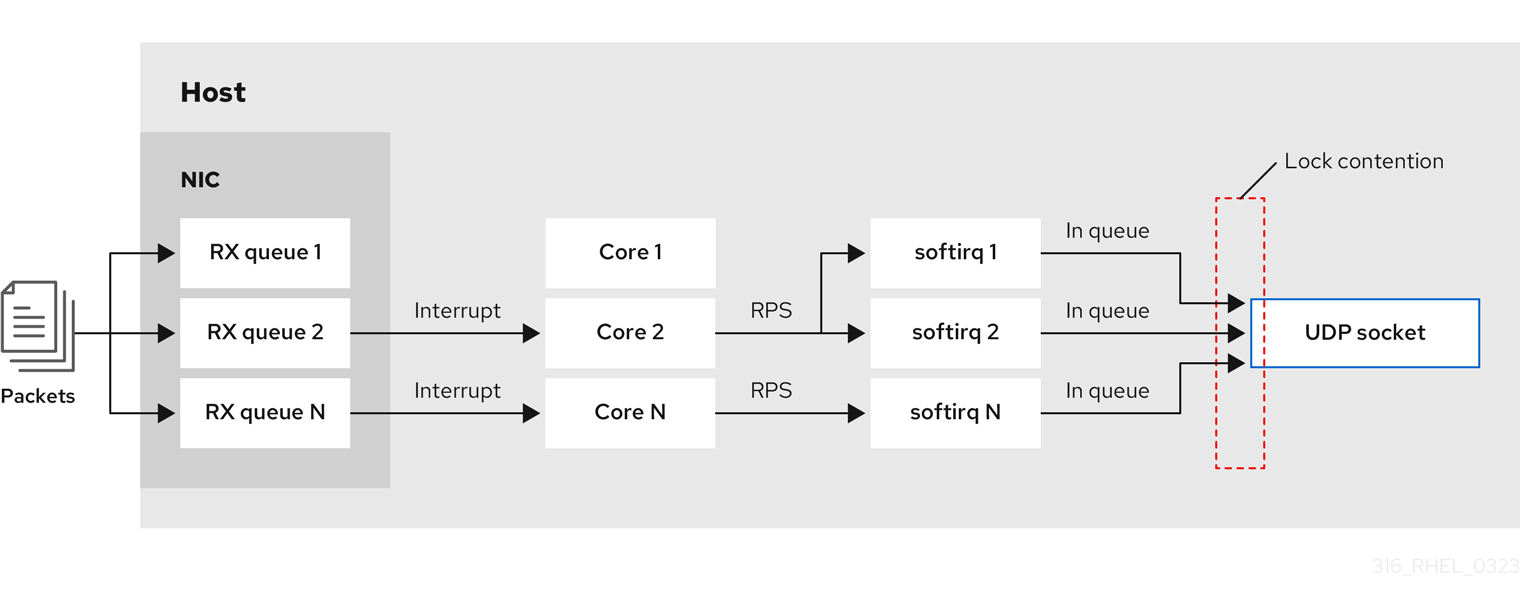

下图显示了如何使用 cpu-partitioning 配置集。这个示例使用 CPU 和节点布局。

图 1.1. cpu-partitioning 图

您可以使用以下配置选项在 /etc/tuned/cpu-partitioning-variables.conf 文件中配置 cpu-partitioning 配置集:

- 带有负载均衡的隔离 CPU

在 cpu-partitioning 图中,从 4 到 23 编号的块是默认的隔离 CPU。在这些 CPU 上启用了内核调度程序的进程负载均衡。它专为需要内核调度程序负载平衡的多个线程的低延迟进程而设计。

您可以使用

isolated_cores=cpu-list选项在/etc/tuned/cpu-partitioning-variables.conf文件中配置 cpu-partitioning 配置集,它列出了 CPU 来隔离将使用内核调度程序负载平衡。隔离的 CPU 列表用逗号分开,也可以使用一个短划线(如

3-5)指定范围。这个选项是必须的。这个列表中缺少的任何 CPU 会自动被视为内务 CPU。- 没有负载均衡的隔离 CPU

在 cpu-partitioning 图中,编号为 2 和 3 的块是不提供任何其他内核调度程序进程负载均衡的隔离 CPU。

您可以使用

no_balance_cores=cpu-list选项在/etc/tuned/cpu-partitioning-variables.conf文件中配置 cpu-partitioning 配置集,它列出了不使用内核调度程序负载平衡的 CPU。指定

no_balance_cores选项是可选的,但此列表中的任何 CPU 都必须是isolated_cores列表中所列 CPU 的子集。使用这些 CPU 的应用程序线程需要单独固定到每个 CPU。

- 日常 CPU

-

在

cpu-partitioning-variables.conf文件中没有隔离的 CPU 会自动被视为内务 CPU。在内务 CPU 上,允许执行所有服务、守护进程、用户进程、可移动内核线程、中断处理程序和内核计时器。

其他资源

-

tuned-profiles-cpu-partitioning (7)man page

1.8. 使用 TuneD cpu-partitioning 配置集进行低延迟调整

这个步骤描述了如何使用 TuneD 的 cpu-partitioning 配置集为低延迟调整系统。它使用了低延迟应用的示例,它可以使用 cpu-partitioning 和 CPU 布局,如 cpu-partitioning 图中所述。

本例中的应用程序使用了:

- 从网络读取数据的专用的 reader 线程将固定到 CPU 2。

- 处理此网络数据的大量线程将固定到 CPU 4-23。

- 将处理的数据写入网络的专用写入器线程将固定到 CPU 3。

先决条件

-

您已以 root 用户身份,使用

dnf install tuned-profiles-cpu-partitioning命令安装cpu-partitioningTuneD 配置集。

步骤

编辑

/etc/tuned/cpu-partitioning-variables.conf文件并添加以下信息:# All isolated CPUs: isolated_cores=2-23 # Isolated CPUs without the kernel’s scheduler load balancing: no_balance_cores=2,3

设置

cpu-partitioningTuneD 配置集:# tuned-adm profile cpu-partitioning

重启

重新引导后,将根据 cpu-partitioning 图中的隔离,为低延迟调优。该应用可以使用 taskset 将读取器和写入器线程固定到 CPU 2 和 3,以及 CPU 4-23 上剩余的应用程序线程。

其他资源

-

tuned-profiles-cpu-partitioning (7)man page

1.9. 自定义 cpu-partitioning TuneD 配置集

您可以扩展 TuneD 配置集,以进行额外的性能优化更改。

例如,cpu-partitioning 配置集将 CPU 设置为使用 cstate=1。要使用 cpu-partitioning 配置集,但额外将 CPU cstate 从 cstate1 更改为 cstate0,以下流程描述了一个新的 TuneD 配置集,名称为 my_profile,它继承 cpu-partitioning 配置集,然后设置 C state-0。

步骤

创建

/etc/tuned/my_profile目录:# mkdir /etc/tuned/my_profile在此目录中创建

tuned.conf文件并添加以下内容:# vi /etc/tuned/my_profile/tuned.conf [main] summary=Customized tuning on top of cpu-partitioning include=cpu-partitioning [cpu] force_latency=cstate.id:0|1使用新配置集:

# tuned-adm profile my_profile

在共享示例中,不需要重新启动。但是,如果 my_profile 配置集中的更改需要重新引导才能生效,则重新启动计算机。

其他资源

-

tuned-profiles-cpu-partitioning (7)man page

1.10. RHEL 提供的实时 TuneD 配置集

实时配置集适用于运行实时内核的系统。如果没有特殊的内核构建,则不会将系统配置为实时。在 RHEL 上,配置集可从额外的软件仓库获得。

可用的实时配置集如下:

realtime在裸机实时系统上使用。

由

tuned-profiles-realtime软件包提供,该软件包可从 RT 或 NFV 存储库中获得。realtime-virtual-host在为实时配置的虚拟化主机中使用。

由

tuned-profiles-nfv-host软件包提供,该软件包可通过 NFV 存储库获取。realtime-virtual-guest在为实时配置的虚拟化客户端中使用。

由

tuned-profiles-nfv-guest软件包提供,该软件包可通过 NFV 存储库获取。

1.11. TuneD 中的静态和动态性能优化

在决定对于给定情况或目的使用哪种方法时,了解应用 TuneD 的两种系统调优(static和dynamic)之间的区别非常重要。

- 静态调整

-

主要由预定义的

sysctl和sysfs设置的应用程序组成,以及激活多个配置工具(如ethtool)的一次性激活。 - 动态调整

监视如何在系统正常运行时间期间使用各种系统组件。tuned 根据监控信息动态调整系统设置。

例如,硬盘驱动器在启动和登录期间大量使用,但当用户主要可能与 Web 浏览器或电子邮件客户端等应用程序工作时,通常使用。同样,CPU 和网络设备在不同时间上有所不同。TuneD 监控这些组件的活动,并对使用中的更改做出反应。

默认情况下禁用动态性能优化。要启用它,请编辑

/etc/tuned/tuned-main.conf文件并将dynamic_tuning选项改为1。然后 TuneD 会定期分析系统统计信息,并使用它们更新您的系统调优设置。要在这些更新之间配置时间间隔(以秒为单位),请使用update_interval选项。目前实施了动态调优算法,尝试平衡性能和节能,因此在性能配置集中禁用。可以在 TuneD 配置集中启用或禁用各个插件的动态性能优化。

例 1.2. 工作站上的静态和动态调优

在典型的办公室工作站上,以太网网络接口在大多数时间都不活跃。通常只会发送和接收一些电子邮件,或载入一些网页。

对于这些负载,网络接口不必像默认情况那样始终全速运行。TuneD 为网络设备有一个监控和调优插件,可检测此低活动,然后自动降低该接口的速度,通常会实现较低的功耗。

如果在较长的时间内接口上的活动增加,例如:因为下载了 DVD 镜像或打开了带有大量附加的电子邮件,则 TuneD 会检测到这个信息,并设置接口速度的最大速度,以便在活动级别高时提供最佳性能。

这个原则还用于 CPU 和磁盘的其他插件。

1.12. TuneD no-daemon(非守护进程)模式

您可以在 no-daemon 模式下运行 TuneD,它不需要任何常驻内存。在这个模式中,TuneD 应用设置并退出。

默认情况下,no-daemon 模式被禁用,因为在这个模式中缺少大量 TuneD 功能,包括:

- D-Bus 支持

- 热插支持

- 对设置进行回滚支持

要启用 no-daemon 模式,请在 /etc/tuned/tuned-main.conf 文件中包含以下行:

daemon = 0

1.13. 安装并启用 TuneD

此流程安装并启用 TuneD 应用程序,安装 TuneD 配置集,并为您的系统预设默认 TuneD 配置集。

流程

安装

Tuned软件包:# dnf install tuned

启用并启动

TuneD服务:# systemctl enable --now tuned

另外,还可为实时系统安装 TuneD 配置集:

对于实时系统的 TuneD 配置文件,启用

rhel-9存储库。# subscription-manager repos --enable=rhel-9-for-x86_64-nfv-beta-rpms

安装它。

# dnf install tuned-profiles-realtime tuned-profiles-nfv

验证 TuneD 配置集是否活跃并应用:

$ tuned-adm active Current active profile: throughput-performance注意活跃的配置文件 TuneD 会根据您的机器类型和系统设置会自动进行不同的预置。

$ tuned-adm verify Verification succeeded, current system settings match the preset profile. See tuned log file ('/var/log/tuned/tuned.log') for details.

1.14. 列出可用的 TuneD 配置集

此流程列出了系统中当前可用的所有 TuneD 配置集。

步骤

要列出系统中的所有可用 TuneD 配置集,请使用:

$ tuned-adm list Available profiles: - accelerator-performance - Throughput performance based tuning with disabled higher latency STOP states - balanced - General non-specialized TuneD profile - desktop - Optimize for the desktop use-case - latency-performance - Optimize for deterministic performance at the cost of increased power consumption - network-latency - Optimize for deterministic performance at the cost of increased power consumption, focused on low latency network performance - network-throughput - Optimize for streaming network throughput, generally only necessary on older CPUs or 40G+ networks - powersave - Optimize for low power consumption - throughput-performance - Broadly applicable tuning that provides excellent performance across a variety of common server workloads - virtual-guest - Optimize for running inside a virtual guest - virtual-host - Optimize for running KVM guests Current active profile: balanced

要只显示当前活跃的配置集,请使用:

$ tuned-adm active Current active profile: throughput-performance

其他资源

-

tuned-adm (8)手册页.

1.15. 设置 TuneD 配置集

此流程激活系统中的所选 TuneD 配置集。

先决条件

-

TuneD服务正在运行。详情请参阅安装和启用 TuneD。

步骤

另外,您可以让 TuneD 为您的系统推荐最合适的配置集:

# tuned-adm recommend throughput-performance激活配置集:

# tuned-adm profile selected-profile另外,您可以激活多个配置集的组合:

# tuned-adm profile selected-profile1 selected-profile2

例 1.3. 为低功耗优化的虚拟机

以下示例优化了在虚拟机中运行的系统,以获得最佳性能,并同时将其调优以实现低功耗,低功耗比高性能有更高优先级:

# tuned-adm profile virtual-guest powersave

查看系统中当前活跃的 TuneD 配置集:

# tuned-adm active Current active profile: selected-profile重启系统:

# reboot

验证步骤

验证 TuneD 配置集是否活跃并应用:

$ tuned-adm verify Verification succeeded, current system settings match the preset profile. See tuned log file ('/var/log/tuned/tuned.log') for details.

其他资源

-

tuned-adm (8)手册页

1.16. 禁用 TuneD

此流程禁用 TuneD,并将所有受影响的系统设置重置为其原始状态,然后再修改 TuneD。

步骤

临时禁用所有调整:

# tuned-adm off

调整会在

TuneD服务重启后再次应用。或者,要永久停止并禁用

TuneD服务:# systemctl disable --now tuned

其他资源

-

tuned-adm (8)手册页

第 2 章 自定义 TuneD 配置集

您可以创建或修改 TuneD 配置集来优化预期的用例的系统性能。

先决条件

- 安装并启用 TuneD,如安装和启用 TuneD 所述。

2.1. 调优配置集

系统的详细分析可能会非常耗时。TuneD 为典型的用例提供了很多预定义的配置集。您还可以创建、修改和删除配置集。

TuneD 提供的配置集被分为以下几个类别:

- 节能配置集

- 性能提升配置集

性能提升配置集包括侧重于以下方面的配置集:

- 存储和网络的低延迟

- 存储和网络的高吞吐量

- 虚拟机性能

- 虚拟化主机性能

配置集配置的语法

tuned.conf 文件可以包含一个 [main] 部分,其他部分用于配置插件实例。但是,所有部分都是可选的。

以 hash 符号 (#) 开头的行是注释。

其他资源

-

tuned.conf (5)手册页.

2.2. 默认 TuneD 配置集

在安装过程中,将自动选择您的系统的最佳配置集。目前,会根据以下自定义规则选择默认配置集:

| 环境 | 默认配置集 | 目标 |

|---|---|---|

| Compute 节点 |

| 最佳吞吐量性能 |

| 虚拟机 |

|

最佳的性能。如果实现最佳性能并不是您最需要考虑的,可以将其改为 |

| 其他情况 |

| 平衡性能和能源消耗 |

其他资源

-

tuned.conf (5)手册页.

2.3. 合并的 TuneD 配置集

作为实验性功能,可以一次性选择更多配置集。tuned 将尝试在负载期间合并它们。

如果存在冲突,则最后指定的配置集的设置会优先使用。

例 2.1. 虚拟客户端中低功耗

以下示例优化了在虚拟机中运行的系统,以获得最佳性能,并同时将其调优以实现低功耗,低功耗比高性能有更高优先级:

# tuned-adm profile virtual-guest powersave

合并会在不检查生成的参数组合是否有意义的情况下自动进行。因此,该功能可能会以相反的方式调整一些参数,这么做可能会影响生产效率。例如,使用 throughput-performance 配置集针对高吞吐量设置磁盘,但当前通过 spindown-disk 配置集将磁盘旋转设置为低值。

其他资源

*tuned-adm man page。* tuned.conf (5) man page。

2.4. TuneD 配置集的位置

TuneD 配置集存储在以下目录中:

/usr/lib/tuned/-

特定于分发的配置文件存储在目录中。每个配置集都有自己的目录。该配置集由名为

tuned.conf的主配置文件以及其他文件(如帮助程序脚本)组成。 /etc/tuned/-

如果您需要自定义配置集,请将配置集目录复制到用于自定义配置集的目录中。如果同一名称有两个配置集,则使用位于

/etc/tuned/中的自定义配置集。

其他资源

-

tuned.conf (5)手册页.

2.5. TuneD 配置集之间的继承

TuneD 配置集可以基于其他配置集,仅修改其父级配置集的某些方面。

TuneD 配置集的 [main] 部分可以识别 include 选项:

[main]

include=parent父 配置集中的所有设置都会加载到此 子 配置集中。在以下小节中,child 配置集可以覆盖从 parent 配置集继承的特定设置,或者添加 parent 配置集中没有的新设置。

您可以基于 /usr/lib/tuned/ 中预安装的配置集,在 /etc/tuned/ 目录中创建自己的 child 配置集并调整了一些参数。

如果对 parent 配置集(如 TuneD 升级后)进行了更新,则更改会反映在 child 配置集中。

例 2.2. 基于均衡的节能配置集

以下是一个可扩展 balanced 配置集的自定义配置集,并将所有设备的主动链路电源管理 (ALPM) 设置为最大节能项。

[main] include=balanced [scsi_host] alpm=min_power

其他资源

-

tuned.conf (5)手册页

2.6. TuneD 中的静态和动态性能优化

在决定对于给定情况或目的使用哪种方法时,了解应用 TuneD 的两种系统调优(static和dynamic)之间的区别非常重要。

- 静态调整

-

主要由预定义的

sysctl和sysfs设置的应用程序组成,以及激活多个配置工具(如ethtool)的一次性激活。 - 动态调整

监视如何在系统正常运行时间期间使用各种系统组件。tuned 根据监控信息动态调整系统设置。

例如,硬盘驱动器在启动和登录期间大量使用,但当用户主要可能与 Web 浏览器或电子邮件客户端等应用程序工作时,通常使用。同样,CPU 和网络设备在不同时间上有所不同。TuneD 监控这些组件的活动,并对使用中的更改做出反应。

默认情况下禁用动态性能优化。要启用它,请编辑

/etc/tuned/tuned-main.conf文件并将dynamic_tuning选项改为1。然后 TuneD 会定期分析系统统计信息,并使用它们更新您的系统调优设置。要在这些更新之间配置时间间隔(以秒为单位),请使用update_interval选项。目前实施了动态调优算法,尝试平衡性能和节能,因此在性能配置集中禁用。可以在 TuneD 配置集中启用或禁用各个插件的动态性能优化。

例 2.3. 工作站上的静态和动态调优

在典型的办公室工作站上,以太网网络接口在大多数时间都不活跃。通常只会发送和接收一些电子邮件,或载入一些网页。

对于这些负载,网络接口不必像默认情况那样始终全速运行。TuneD 为网络设备有一个监控和调优插件,可检测此低活动,然后自动降低该接口的速度,通常会实现较低的功耗。

如果在较长的时间内接口上的活动增加,例如:因为下载了 DVD 镜像或打开了带有大量附加的电子邮件,则 TuneD 会检测到这个信息,并设置接口速度的最大速度,以便在活动级别高时提供最佳性能。

这个原则还用于 CPU 和磁盘的其他插件。

2.7. TuneD 插件

插件是 TuneD 配置集中的模块,TuneD 使用它们监控或优化系统上的不同设备。

TuneD 使用两种类型的插件:

- 监控插件

监控插件用于从正在运行的系统中获取信息。通过调优插件进行动态调优,可以使用监控插件的输出。

当任何已启用的调优插件需要指标时,监控插件会自动实例化。如果两个调优插件需要相同的数据,则只创建一个监控插件的实例,并且数据会被共享。

- 调优插件

- 每个调优插件对单个子系统进行调优,并会获取从 TuneD 配置集填充的多个参数。每个子系统可以有多个设备,如多个 CPU 或网卡,这些设备由调优插件的单个实例处理。还支持单个设备的具体设置。

TuneD 配置集中的插件语法

描述插件实例的部分采用以下格式:

[NAME] type=TYPE devices=DEVICES

- NAME

- 是插件实例的名称,在日志中使用。它可以是一个任意字符串。

- TYPE

- 是调优插件的类型。

- DEVICES

是此插件实例处理的设备列表。

devices行可以包含一个列表、通配符 (*) 和负效果 (!) 。如果没有devices行,则插件实例处理所有在 TYPE 系统中附加的所有设备。这与使用devices=*选项相同。例 2.4. 使用插件匹配块设备

以下示例与以

sd开头的所有块设备(如sda或sdb)匹配,且不禁用这些块设备:[data_disk] type=disk devices=sd* disable_barriers=false

以下示例与

sda1和sda2以外的所有块设备匹配:[data_disk] type=disk devices=!sda1, !sda2 disable_barriers=false

如果没有指定插件的实例,则不会启用插件。

如果插件支持更多选项,也可以在插件部分中指定它们。如果没有指定选项,且之前未在 included 插件中指定,则使用默认值。

简短插件语法

如果您的插件实例不需要使用自定义名称,且配置文件中只有一个定义,则 TuneD 支持以下短语法:

[TYPE] devices=DEVICES

在这种情况下,可以省略 type 行。然后,实例使用名称来指代,与类型相同。然后,前面的示例可重写为:

例 2.5. 使用简短语法匹配块设备

[disk] devices=sdb* disable_barriers=false

配置集中的冲突插件定义

如果使用 include 选项指定同一部分,则会合并设置。如果因为冲突而无法合并它们,则最后冲突的定义会覆盖上一个设置。如果您不知道之前定义的内容,您可以使用 replace 布尔值选项并将其设置为 true。这会导致之前带有相同名称的定义被覆盖,且不会出现合并。

您还可以通过指定 enabled=false 选项来禁用插件。这与实例从未定义的影响相同。如果您从 include 选项重新定义之前定义,且不想在自定义配置集中激活插件,则禁用插件会很有用。

- 注意

TuneD 包含了作为启用或禁用调优配置文件的一部分来运行任何 shell 命令的功能。这可让您使用尚未集成到 TuneD 的功能扩展 TuneD 配置集。

您可以使用

script插件指定任意 shell 命令。

其他资源

-

tuned.conf (5)手册页

2.8. 可用的 TuneD 插件

监控插件

目前,实施了以下监控插件:

disk- 每个设备获取磁盘负载(IO 操作数)和测量间隔。

net- 每个网卡获取网络负载(传输数据包的数量)和测量间隔。

load- 获取每个 CPU 的 CPU 负载和测量间隔。

调优插件

目前,实施了以下调优插件。只有其中一些插件实施动态性能优化。列出插件支持的选项:

cpu将 CPU 调控器设置为

governor选项指定的值,并根据 CPU 负载动态更改电源管理服务质量 (PM QoS) CPU Direct Memory Access (DMA) 延迟。如果 CPU 负载低于

load_threshold选项指定的值,则延迟设置为由latency_high选项指定的值,否则它将设置为latency_low指定的值。您还可以强制对特定值强制延迟并阻止它动态更改。要做到这一点,将

force_latency选项设置为所需的延迟值。eeepc_she根据 CPU 负载动态设置前端总线 (FSB) 速度。

此功能可在一些笔记本电脑中找到,也称为 ASUS Super Hybrid Engine (SHE) 。

如果 CPU 负载较低或等于

load_threshold_powersave选项指定的值,则插件会将 FSB 速度设置为she_powersave选项指定的值。如果 CPU 负载较高或等于load_threshold_normal选项指定的值,它会将 FSB 速度设置为she_normal选项指定的值。不支持静态调优,如果 TuneD 不检测到对这个功能的硬件支持,则插件会被透明禁用。

net-

将 Wake-on-LAN 功能配置为

wake_on_lan选项指定的值。它使用与ethtool实用程序相同的语法。它还会根据接口利用率动态更改接口速度。 sysctl设置由插件选项指定的各种

sysctl设置。语法为

name=value,其中 name 与sysctl实用程序提供的名称相同。如果您需要更改 TuneD 中其他插件所涵盖的系统设置,请使用

sysctl插件。如果某些特定插件提供了设置,首选这些插件。usb将 USB 设备的自动暂停超时设置为

autosuspend参数指定的值。值

0表示禁用自动暂停。vm启用或禁用透明大内存页,具体取决于 transparent

_hugepages选项的值。transparent_hugepages选项的有效值为:- "always"

- "never"

- "madvise"

audio将音频解码器的 autosuspend timeout 设置为

timeout选项指定的值。目前,支持

snd_hda_intel和snd_ac97_codeccodec。值0表示自动暂停已被禁用。您还可以通过将 布尔值选项reset_controller设置为true来强制实施控制器重置。disk将磁盘电梯设置为

elevator选项指定的值。它还设置:

-

apm选项指定的值的 APM -

调度程序对由

scheduler_quantum选项指定的值进行量化 -

磁盘 spindown 的超时值由

spindown选项指定的值 -

磁盘的 readahead 会到

readahead参数指定的值 -

当前磁盘 readahead 值乘以

readahead_multiply选项指定的常数

此外,此插件根据当前的驱动器利用率动态地更改驱动器的高级电源管理和机超时设置。动态调优可以由布尔值选项

动态控制,默认情况下是启用的。-

scsi_hostSCSI 主机的选项调整。

它将积极链接电源管理 (ALPM) 设置为

alpm选项指定的值。mounts-

根据

disable_barriers选项的布尔值启用或禁用挂载障碍。 script加载或卸载配置集时,执行外部脚本或二进制代码。您可以选择任意可执行文件。

重要script插件主要被用来与更早的版本兼容。如果其他 TuneD 插件涵盖所需的功能,则首选其他 TuneD 插件。TuneD 使用以下参数之一调用可执行文件:

-

在载入配置集时

start -

在卸载配置集时

stop

您需要在可执行文件中正确实施

stop操作,并恢复您在start操作过程中更改的所有设置。否则,在更改 TuneD 配置集后回滚步骤将无法正常工作。Bash 脚本可以导入

/usr/lib/tuned/functionsBash 库,并使用那里定义的功能。只在由 TuneD 原生提供的功能中使用这些功能。如果函数名称以下划线开头,如_wifi_set_power_level,请考虑函数私有且不要在脚本中使用,因为它可能会在以后有所变化。使用插件配置中的

script参数指定可执行文件的路径。例 2.6. 从配置集运行 Bash 脚本

要运行位于配置集目录中的

script.sh的 Bash 脚本,请使用:[script] script=${i:PROFILE_DIR}/script.sh-

在载入配置集时

sysfs设置由插件选项指定的各种

sysfs设置。语法为

name=value,其中 name 是要使用的sysfs路径。如果需要更改其他插件未涵盖的一些设置,请使用此插件。如果插件涵盖所需的设置,则首选插件。

video在视频卡中设置各种电源保存级别。目前,只支持 Radeon 卡。

可以使用

radeon_powersave选项指定节能级别。支持的值有:-

default -

auto -

低 -

mid -

high -

dynpm -

dpm-battery -

dpm-balanced -

dpm-perfomance

详情请查看 www.x.org。请注意,此插件是实验性的,选项可能会在以后的版本中有所变化。

-

bootloader在内核命令行中添加选项。这个插件只支持 GRUB 2 引导装载程序。

grub2_cfg_file选项指定 GRUB 2 配置文件的自定义非标准位置。内核选项会添加到当前 GRUB 配置及其模板中。需要重新引导系统才能使内核选项生效。

切换到另一个配置集或手动停止

TuneD服务会删除附加选项。如果您关闭或重启系统,则 kernel 选项会在grub.cfg文件中保留。内核选项可使用以下语法指定:

cmdline=arg1 arg2 ... argN

例 2.7. 修改内核命令行

例如,要将

quietkernel 选项添加到 TuneD 配置集中,请在tuned.conf文件中包括以下行:[bootloader] cmdline=quiet

以下是在内核命令行中添加

isolcpus=2选项的自定义配置集示例:[bootloader] cmdline=isolcpus=2

service处理由插件选项指定的各种

sysvinit、sysv-rc、openrc和systemd服务。语法为

service.service_name=command[,file:file]。支持的服务处理命令有:

-

start -

stop -

enable -

disable

使用逗号(

、)或分号(;)分隔多个命令。如果指令冲突,service插件将使用最后列出的。使用可选的

file:file指令,仅为systemd安装一个覆盖配置文件file。其他 init 系统会忽略这个指令。service插件将覆盖配置文件复制到/etc/systemd/system/service_name.service.d/目录中。卸载配置文件后,如果目录为空,service插件会删除它们。注意service插件仅在带有非systemdinit 系统的当前运行级别上运行。例 2.8. 启动并启用带有覆盖文件的sendmail

sendmail服务[service] service.sendmail=start,enable,file:${i:PROFILE_DIR}/tuned-sendmail.conf内部变量

${i:PROFILE_DIR}指向插件从中加载配置文件的目录。-

scheduler- 提供调优调度优先级的各种选项,CPU 核隔离,以及进程、线程和 IRQ 相关性。

有关可用的不同选项的具体内容,请参阅 scheduler TuneD 插件的功能。

2.9. scheduler TuneD 插件的功能

使用 scheduler TuneD 插件控制并调优调度优先级、CPU 核隔离和进程、线程和 IRQ 相关性。

CPU 隔离

要防止进程、线程和 IRQ 使用某些 CPU,请使用 isolated_cores 选项。它更改进程和线程关联性、IRQ 关联性,并为 IRQ 设置 default_smp_affinity 参数。

根据 sched_setaffinity() 系统调用的成功,对与 ps_whitelist 选项匹配的所有进程和线程,会调整 CPU 关联性掩码。ps_whitelist 正则表达式的默认设置是 .*,以匹配所有进程和线程名称。要排除某些进程和线程,请使用 ps_blacklist 选项。这个选项的值也被解释为一个正则表达式。进程和线程名称与该表达式匹配。配置文件回滚可让所有匹配的进程和线程在所有 CPU 上运行,并在配置文件应用程序之前恢复 IRQ 设置。

对于 ps_whitelist 和 ps_blacklist 选项,支持用 ; 分隔的多个正则表达式。转义的分号 \; 按字面处理。

例 2.9. 隔离 CPU 2-4

以下配置隔离 CPU 2-4.与 ps_blacklist 正则表达式匹配的进程和线程可以使用任何 CPU,而不考虑隔离:

[scheduler] isolated_cores=2-4 ps_blacklist=.*pmd.*;.*PMD.*;^DPDK;.*qemu-kvm.*

IRQ SMP 关联性

/proc/irq/default_smp_affinity 文件包含一个位掩码,表示系统上所有不活跃中断请求(IRQ)源的的默认目标 CPU 核。激活或分配 IRQ 后,/proc/irq/default_smp_affinity 文件中的值决定 IRQ 的关联性位掩码。

default_irq_smp_affinity 参数控制 TuneD 向 /proc/irq/default_smp_affinity 文件中写入什么。default_irq_smp_affinity 参数支持以下值和行为:

calc从

isolated_cores参数计算/proc/irq/default_smp_affinity文件的内容。isolated_cores参数的反转计算非隔离核。然后,将非隔离核和之前

/proc/irq/default_smp_affinity文件的交集写入/proc/irq/default_smp_affinity文件中。如果省略了

default_irq_smp_affinity参数,则这是默认行为。ignore-

TuneD 不修改

/proc/irq/default_smp_affinity文件。 - CPU 列表

使用单个数字的形式,如

1,逗号分隔的列表,如1、3或范围,如3-5。解开 CPU 列表,并将其直接写到

/proc/irq/default_smp_affinity文件中。

例 2.10. 使用显式 CPU 列表设置默认的 IRQ smp 关联性

以下示例使用显式 CPU 列表将默认的 IRQ SMP 关联性设置为 CPU 0 和 2:

[scheduler] isolated_cores=1,3 default_irq_smp_affinity=0,2

调度策略

要调整一组进程或线程的调度策略、优先级和关联性,请使用以下语法:

group.groupname=rule_prio:sched:prio:affinity:regex

其中 rule_prio 定义规则的内部 TuneD 优先级。规则根据优先级排序。这是继承的需要,以能够重新排序之前定义的规则。应按照定义的顺序处理相同的 rule_prio 规则。但是,这是依赖于 Python 解释器。要禁用 groupname 的一个继承规则,请使用:

group.groupname=

sched 必须是以下之一:

f- 对于先进先出(FIFO)

b- 对于批处理

r- 对于循环

o- 对于其他

*- 对于不更改

关联性 是十六进制的 CPU 关联性。对于没有更改,使用 *。

prio 是调度优先级(请参阅 chrt -m)。

regex 是 Python 正则表达式。它与 ps -eo cmd 命令的输出匹配。

任何给定的进程名称可以匹配多个组。在这种情况下,最后匹配的 regex 决定优先级和调度策略。

例 2.11. 设置调度策略和优先级

以下示例对内核线程和 watchdog 设置调度策略和优先级:

[scheduler] group.kthreads=0:*:1:*:\[.*\]$ group.watchdog=0:f:99:*:\[watchdog.*\]

scheduler 插件使用 perf 事件循环来识别新创建的进程。默认情况下,它侦听 perf.RECORD_COMM 和 perf.RECORD_EXIT 事件。

将 perf_process_fork 参数设置为 true ,来告知插件也侦听 perf.RECORD_FORK 事件,这意味着由 fork () 系统调用创建的子进程已被处理。

处理 perf 事件可能会造成大量 CPU 开销。

可以使用 scheduler runtime 选项来缓解scheduler 插件的 CPU 开销,并将其设置为 0。这会完全禁用动态 scheduler 功能,并且不会对 perf 事件进行监控和操作。这样做的缺点是,进程和线程调优只能在配置文件应用程序中完成。

例 2.12. 禁用动态 scheduler 功能

以下示例禁用了动态 scheduler 功能,同时也隔离了 CPU 1 和 3:

[scheduler] runtime=0 isolated_cores=1,3

mmapped 缓冲用于 perf 事件。在负载过重时,此缓冲区可能会溢出,因此插件可能会开始丢失事件,不会处理一些新创建的进程。在这种情况下,使用 perf_mmap_pages 参数来增加缓冲区大小。perf_mmap_pages 参数的值必须是 2 的幂。如果没有手动设置 perf_mmap_pages 参数,则使用默认值 128。

使用 cgroups 的限制

scheduler 插件支持使用 cgroup v1 的进程和线程限制。

cgroup_mount_point 选项指定挂载 cgroup 文件系统的路径,或者 TuneD 预期它挂载在哪里。如果未设置,则预期为 /sys/fs/cgroup/cpuset。

如果 cgroup_groups_init 选项被设置为 1,则TuneD 会创建和删除使用 cgroup* 选项定义的所有 cgroups。这是默认的行为。如果 cgroup_mount_point 选项设为 0 ,则必须使用其他方法预设置 cgroups。

如果 cgroup_mount_point_init 选项被设置为 1,则TuneD 会创建和删除 cgroup 挂载点。其暗示 cgroup_groups_init = 1。如果 cgroup_mount_point_init 选项被设置为 0,则必须通过其他方法预设置 cgroups 挂载点。这是默认的行为。

cgroup_for_isolated_cores 选项是 isolated_cores 选项功能的 cgroup 名称。例如,如果系统有 4 个 CPU,isolated_cores=1 表示 Tuned 将所有进程和线程移到 CPU 0、2 和 3。scheduler 插件通过将计算的 CPU 关联性写入指定 cgroup 的 cpuset.cpus 控制文件来隔离指定的核,并将所有匹配的进程和线程移到这个组中。如果此选项未设置,则使用 sched_setaffinity () 的经典 cpuset 关联性设置 CPU 关联性。

cgroup.cgroup_name 选项为任意 cgroup 定义关联性。您甚至可以使用层次结构的 cgroups,但您必须按正确顺序指定层次结构。TuneD 不会在此处做任何健全性检查,但它会强制 cgroup 位于 cgroup_mount_point 选项指定的位置。

以 group. 开头的 scheduler 选项的语法已被增强来使用 cgroup.cgroup_name,而不是十六进制 关联性。匹配的进程被移到 cgroup cgroup_name 中。您还可以使用不是由 cgroup. 选项定义的 cgroups,如上所述。例如,cgroups 不是由 TuneD 管理的。

所有 cgroup 名称通过使用斜杠(/)替换所有句点(..)来进行清理。这可防止插件写到 cgroup_mount_point 选项指定的位置外。

例 2.13. 使用带有 scheduler 插件的 cgroup v1

以下示例创建 2 个 cgroups,group1 和 group2。它将 cgroup group1 关联性设置为 CPU 2,将 cgroup group2 设置为 CPU 0 和 2。假有定 4 个 CPU 设置,isolated_cores=1 选项将所有进程和线程移到 CPU 核 0、2 和 3。ps_blacklist 正则表达式指定的进程和线程没有移动。

[scheduler] cgroup_mount_point=/sys/fs/cgroup/cpuset cgroup_mount_point_init=1 cgroup_groups_init=1 cgroup_for_isolated_cores=group cgroup.group1=2 cgroup.group2=0,2 group.ksoftirqd=0:f:2:cgroup.group1:ksoftirqd.* ps_blacklist=ksoftirqd.*;rcuc.*;rcub.*;ktimersoftd.* isolated_cores=1

cgroup_ps_blacklist 选项排除了属于指定 cgroup 的进程。此选项指定的正则表达式与 /proc/PID/cgroups 的 cgroup 层次结构匹配。在正则表达式匹配前,逗号(,)将 cgroups v1 层次结构与 /proc/PID/cgroups 分隔开。以下是正则表达式匹配的内容的示例:

10:hugetlb:/,9:perf_event:/,8:blkio:/

多个正则表达式可以通过分号(;)分隔。分号表示逻辑"或"运算符。

例 2.14. 使用 cgroup 从调度程序中排除进程

在以下示例中,scheduler 插件将所有进程从核 1 移出,但属于 cgroup /daemons 的进程除外。\b 字符串是一个与单词边界匹配的正则表达式元字符。

[scheduler] isolated_cores=1 cgroup_ps_blacklist=:/daemons\b

在以下示例中,scheduler 插件排除了属于层次结构 ID 为 8 和 controller-list blkio 的 cgroup 的所有进程。

[scheduler] isolated_cores=1 cgroup_ps_blacklist=\b8:blkio:

最近的内核将一些 sched_ 和 numa_balancing_ 内核运行时参数从 sysctl 工具管理的 /proc/sys/kernel 目录移到 debugfs,通常挂载在 /sys/kernel/debug 目录下。TuneD 通过 scheduler 插件为以下参数提供抽象机制,其中,根据使用的内核,TuneD 将指定的值写到正确的位置:

-

sched_min_granularity_ns -

sched_latency_ns, -

sched_wakeup_granularity_ns -

sched_tunable_scaling, -

sched_migration_cost_ns -

sched_nr_migrate -

numa_balancing_scan_delay_ms -

numa_balancing_scan_period_min_ms -

numa_balancing_scan_period_max_ms numa_balancing_scan_size_mb例 2.15. 为迁移决策设置任务的"cache hot"值。

在旧内核上,设置以下参数意味着

sysctl将值500000写到/proc/sys/kernel/sched_migration_cost_ns文件中:[sysctl] kernel.sched_migration_cost_ns=500000

在最近的内核上,这相当于通过

scheduler插件设置以下参数:[scheduler] sched_migration_cost_ns=500000

意味着 TuneD 将值

500000写到/sys/kernel/debug/sched/migration_cost_ns文件中。

2.10. TuneD 配置集中的变量

激活 TuneD 配置集时,在运行时扩展的变量。

使用 TuneD 变量可减少 TuneD 配置集中必要输入的数量。

TuneD 配置集中没有预定义的变量。您可以通过在配置集中创建 [variables] 部分并使用以下语法来定义您自己的变量:

[variables] variable_name=value

要扩展配置集中的变量的值,请使用以下语法:

${variable_name}例 2.16. 使用变量隔离 CPU 内核

在以下示例中,${isolated_cores} 变量扩展至 1,2; 因此内核使用 isolcpus=1,2 选项引导:

[variables]

isolated_cores=1,2

[bootloader]

cmdline=isolcpus=${isolated_cores}

变量可以在单独的文件中指定。例如,您可以在 tuned.conf 中添加以下行:

[variables]

include=/etc/tuned/my-variables.conf

[bootloader]

cmdline=isolcpus=${isolated_cores}

如果您将 isolated_cores=1,2 选项添加到 /etc/tuned/my-variables.conf 文件,则内核会使用 isolcpus=1,2 选项引导。

其他资源

-

tuned.conf (5)手册页

2.11. TuneD 配置集中的内置功能

当激活 TuneD 配置集时,内置功能会在运行时扩展。

您可以:

- 与 TuneD 变量一起使用各种内置功能

- 在 Python 中创建自定义功能,并以插件的形式将它们添加到 TuneD

要调用函数,请使用以下语法:

${f:function_name:argument_1:argument_2}

要扩展配置集和 tuned.conf 文件所在的目录路径,请使用 PROFILE_DIR 功能,它需要特殊语法:

${i:PROFILE_DIR}例 2.17. 使用变量和内置功能隔离 CPU 内核

在以下示例中, ${non_isolated_cores} 变量扩展至 0,3-5,且 cpulist_invert 内置函数使用 0,3-5 参数调用:

[variables]

non_isolated_cores=0,3-5

[bootloader]

cmdline=isolcpus=${f:cpulist_invert:${non_isolated_cores}}

cpulist_invert 功能反转 CPU 列表。对于 6-CPU 机器,inversion 为 1,2,内核通过 isolcpus=1,2 命令行选项引导。

其他资源

-

tuned.conf (5)手册页

2.12. TuneD 配置集中的内置功能

所有 TuneD 配置集中都有以下内置功能:

PROFILE_DIR-

返回配置文件和

tuned.conf文件所在的目录路径。 exec- 执行进程并返回其输出。

assertion- 比较两个参数。如果不匹配,会在日志中记录来自第一个参数的信息,并中止配置集加载。

assertion_non_equal- 比较两个参数。如果不匹配,会在日志中记录来自第一个参数的信息,并中止配置集加载。

kb2s- 将 KB 转换为磁盘扇区.

s2kb- 将磁盘扇区转换为 KB。

strip- 从所有传递的参数创建字符串,并删除前导和尾随空格。

virt_check检查 TuneD 是否在虚拟机 (VM) 或裸机中运行:

- 在虚拟机内部,函数返回第一个参数。

- 在裸机上,函数返回第二个参数,即使出现错误。

cpulist_invert-

颠倒 CPU 列表,使其补充。例如,在一个有 4 个 CPU 的系统上,从 0 到 3,列表

0,2,3的反转是1。 cpulist2hex- 将 CPU 列表转换为十六进制 CPU 掩码。

cpulist2hex_invert- 将 CPU 列表转换为十六进制 CPU 掩码并进行反转。

hex2cpulist- 将十六进制 CPU 掩码转换为 CPU 列表。

cpulist_online- 检查列表中的 CPU 是否在线。返回仅包含在线 CPU 的列表。

cpulist_present- 检查列表中是否存在 CPU。返回只包含当前 CPU 的列表。

cpulist_unpack-

解包 CPU 列表,格式为

1-3,4到1,2,3,4。 cpulist_pack-

把包 CPU 列表,格式为

1,2,3,5到1-3,5

2.13. 创建新的 TuneD 配置集

此流程使用自定义性能配置集创建一个新的 TuneD 配置集。

先决条件

-

TuneD服务正在运行。详情请参阅安装和启用 TuneD。

步骤

在

/etc/tuned/目录中,创建一个名为您要创建的配置集的新目录:# mkdir /etc/tuned/my-profile在新目录中,创建名为

tuned.conf的文件。根据您的要求,添加一个[main]部分和插件定义。例如,查看

balanced配置集的配置:[main] summary=General non-specialized TuneD profile [cpu] governor=conservative energy_perf_bias=normal [audio] timeout=10 [video] radeon_powersave=dpm-balanced, auto [scsi_host] alpm=medium_power

要激活配置集,请使用:

# tuned-adm profile my-profile验证 TuneD 配置集是否活跃,并应用了系统设置:

$ tuned-adm active Current active profile: my-profile$ tuned-adm verify Verification succeeded, current system settings match the preset profile. See tuned log file ('/var/log/tuned/tuned.log') for details.

其他资源

-

tuned.conf (5)手册页

2.14. 修改现有 TuneD 配置集

此流程根据现有的 TuneD 配置集创建修改后的子配置集。

先决条件

-

TuneD服务正在运行。详情请参阅安装和启用 TuneD。

步骤

在

/etc/tuned/目录中,创建一个名为您要创建的配置集的新目录:# mkdir /etc/tuned/modified-profile在新目录中,创建一个名为

tuned.conf的文件,并按如下所示设置[main]部分:[main] include=parent-profile使用您要修改的配置集的名称替换 parent-profile。

包括您的配置集修改。

例 2.18. 在 throughput-performance 配置集中降低 swappiness

要使用

throughput-performance配置集的设置,并将vm.swappiness的值改为 5,而不是默认的 10,请使用:[main] include=throughput-performance [sysctl] vm.swappiness=5

要激活配置集,请使用:

# tuned-adm profile modified-profile验证 TuneD 配置集是否活跃,并应用了系统设置:

$ tuned-adm active Current active profile: my-profile$ tuned-adm verify Verification succeeded, current system settings match the preset profile. See tuned log file ('/var/log/tuned/tuned.log') for details.

其他资源

-

tuned.conf (5)手册页

2.15. 使用 TuneD 设置磁盘调度程序

此流程创建并启用 TuneD 配置集,该配置集为所选块设备设置给定磁盘调度程序。这个设置会在系统重启后保留。

在以下命令和配置中替换:

-

带有块设备名称的 device,如

sdf -

带有您要为该设备设置的磁盘调度程序的 selected-scheduler,例如

bfq

先决条件

-

TuneD服务已安装并启用。详情请参阅安装和启用 TuneD。

流程

可选:选择一个您的配置集将要基于的现有 Tuned 配置集。有关可用配置集列表,请参阅 RHEL 提供的 TuneD 配置集。

要查看哪个配置集当前处于活跃状态,请使用:

$ tuned-adm active

创建一个新目录来保存 TuneD 配置集:

# mkdir /etc/tuned/my-profile查找所选块设备系统唯一标识符:

$ udevadm info --query=property --name=/dev/device | grep -E '(WWN|SERIAL)' ID_WWN=0x5002538d00000000_ ID_SERIAL=Generic-_SD_MMC_20120501030900000-0:0 ID_SERIAL_SHORT=20120501030900000

注意本例中的命令将返回以 World Wide Name (WWN) 或与指定块设备关联的序列号的所有值。虽然最好使用 WWN,但给定设备始终不能使用 WWN,但 example 命令返回的任何值都可以接受用作 device system unique ID。

创建

/etc/tuned/my-profile/tuned.conf配置文件。在该文件中设置以下选项:可选:包含现有配置集:

[main] include=existing-profile为与 WWN 标识符匹配的设备设置所选磁盘调度程序:

[disk] devices_udev_regex=IDNAME=device system unique id elevator=selected-scheduler

在这里:

-

使用要使用的标识符的名称替换 IDNAME (如

ID_WWN)。 将 device system unique id 替换为所选标识符的值(如

0x5002538d00000000)。要匹配

devices_udev_regex选项中的多个设备,将标识符放在括号中,并使用垂直栏来分离它们:devices_udev_regex=(ID_WWN=0x5002538d00000000)|(ID_WWN=0x1234567800000000)

-

使用要使用的标识符的名称替换 IDNAME (如

启用您的配置集:

# tuned-adm profile my-profile

验证步骤

验证 TuneD 配置集是否活跃并应用:

$ tuned-adm active Current active profile: my-profile$ tuned-adm verify Verification succeeded, current system settings match the preset profile. See TuneD log file ('/var/log/tuned/tuned.log') for details.读取

/sys/block/设备/queue/scheduler文件的内容:# cat /sys/block/device/queue/scheduler [mq-deadline] kyber bfq none在文件名中,将 device 替换为块设备名称,如

sdc。活跃的调度程序列在方括号中 (

[]) 。

其他资源

第 3 章 使用 tuna 接口检查系统

使用 tuna 工具调整调度程序可调项,调优线程优先级、RIRQ 处理程序,并隔离 CPU 内核和插槽。tuna 降低了执行调优任务的复杂性。

tuna 工具执行以下操作:

- 列出系统中的 CPU

- 列出系统中当前运行的中断请求 (IRQ)

- 更改线程的策略和优先级信息

- 显示系统的当前策略和优先级

3.1. 安装 tuna 工具

tuna 工具设计为在运行中的系统上使用。这允许特定应用程序的测量工具在更改后马上查看和分析系统性能。

这个步骤描述了如何安装 tuna 工具。

流程

安装

tuna工具:# dnf install tuna

验证步骤

查看可用的

tunaCLI 选项:# tuna -h

其他资源

-

tuna (8)手册页

3.2. 使用 tuna 工具查看系统状态

这个步骤描述了如何使用 tuna 命令行界面 (CLI) 工具查看系统状态。

先决条件

- tuna 工具已经安装。如需更多信息,请参阅安装 tuna 工具。

流程

查看当前的策略和优先级:

# tuna --show_threads thread pid SCHED_ rtpri affinity cmd 1 OTHER 0 0,1 init 2 FIFO 99 0 migration/0 3 OTHER 0 0 ksoftirqd/0 4 FIFO 99 0 watchdog/0查看与 PID 或命令名称对应的特定线程:

# tuna --threads=pid_or_cmd_list --show_threadspid_or_cmd_list 参数是一个用逗号分开的 PID 或 command-name 模式的列表。

-

要使用

tunaCLI 调整 CPU,请参阅使用 tuna 工具调整 CPU。 -

要使用

tuna工具调整 IRQs,请参阅使用 tuna 工具调整 IRQ。 保存更改的配置:

# tuna --save=filename

这个命令只保存当前运行的内核线程。未运行的进程不会保存。

其他资源

-

tuna (8)手册页

3.3. 使用 tuna 工具调整 CPU

tuna 工具命令可以针对单个 CPU 为目标。

使用 tuna 工具,您可以:

隔离 CPU- 在指定 CPU 上运行的所有任务都移至下一个可用 CPU。隔离 CPU 会将其从所有线程的关联性掩码中删除使其不可用。

包括 CPU- 允许任务在指定的 CPU 上运行

恢复 CPU- 将指定的 CPU 恢复到之前的配置。

这个步骤描述了如何使用 tuna CLI 调整 CPU。

先决条件

- tuna 工具已经安装。如需更多信息,请参阅安装 tuna 工具。

流程

指定要受某一命令影响的 CPU 列表:

# tuna --cpus=cpu_list [command]

cpu_list 参数是一个用逗号分开的 CPU 号列表。例如,

--cpus=0,2。CPU 列表也可以以范围的形式指定,例如--cpus="1-3",这代表选择 CPU 1、2 和 3。要将特定的 CPU 添加到当前的 cpu_list 中,例如,使用

--cpus=+0。将 [command] 替换为例如

--isolate:隔离 CPU:

# tuna --cpus=cpu_list --isolate

包括一个 CPU:

# tuna --cpus=cpu_list --include

以下显示了,在带有四个或更多处理器的系统中,如何在 CPU 0 和 1 上运行所有 ssh 线程,在 CPU 2 和 3 中运行所有

http线程:# tuna --cpus=0,1 --threads=ssh\* \ --move --cpus=2,3 --threads=http\* --move

这个命令会按顺序执行以下操作:

- 选择 CPU 0 和 1。

-

选择以

ssh开头的所有线程。 -

将所选线程移到所选 CPU。tuna 设置线程的关联掩码,从

ssh开始到适当的 CPU。CPU 可以数字形式表示为 0 和 1,掩码为 0x3(十六进制),或 11(二进制)。 - 将 CPU 列表重置为 2 和 3。

-

选择所有以

http开头的线程。 -

将所选线程移到指定的 CPU。tuna 将以

http开始的线程的关联掩码设置为指定的 CPU。CPU 可以数字化为 2 和 3,掩码为 0xC(十六进制),或 1100(二进制)。

验证步骤

显示当前配置并验证更改是否已如预期执行:

# tuna --threads=gnome-sc\* --show_threads \ --cpus=0 --move --show_threads --cpus=1 \ --move --show_threads --cpus=+0 --move --show_threads thread ctxt_switches pid SCHED_ rtpri affinity voluntary nonvoluntary cmd 3861 OTHER 0 0,1 33997 58 gnome-screensav thread ctxt_switches pid SCHED_ rtpri affinity voluntary nonvoluntary cmd 3861 OTHER 0 0 33997 58 gnome-screensav thread ctxt_switches pid SCHED_ rtpri affinity voluntary nonvoluntary cmd 3861 OTHER 0 1 33997 58 gnome-screensav thread ctxt_switches pid SCHED_ rtpri affinity voluntary nonvoluntary cmd 3861 OTHER 0 0,1 33997 58 gnome-screensav

这个命令会按顺序执行以下操作:

-

选择以

gnome-sc线程开头的所有线程。 - 显示所选线程,以便用户验证其关联性掩码和 RT 优先级。

- 选择 CPU 0。

-

将

gnome-sc线程移到指定的 CPU CPU 中,CPU 0。 - 显示移动的结果。

- 将 CPU 列表重置为 CPU 1。

-

将

gnome-sc线程移到指定的 CPU 1 中。 - 显示移动的结果。

- 将 CPU 0 添加到 CPU 列表中。

-

将

gnome-sc线程移到指定的 CPU,CPU 0 和 1。 - 显示移动的结果。

-

选择以

其他资源

-

/proc/cpuinfo文件 -

tuna (8)手册页

3.4. 使用 tuna 工具调整 IRQ

/proc/interrupts 文件记录每个 IRQ 的中断数、中断类型和位于 IRQ 的设备的名称。

这个步骤描述了如何使用 tuna 工具调整 IRQ。

先决条件

- tuna 工具已经安装。如需更多信息,请参阅安装 tuna 工具。

流程

查看当前的 IRQs 及其关联性:

# tuna --show_irqs # users affinity 0 timer 0 1 i8042 0 7 parport0 0

指定要受某一命令影响的 IRQs 列表:

# tuna --irqs=irq_list [command]

irq_list 参数是用逗号分开的 IRQ 编号或 user-name 模式的列表。

将 [command] 替换为例如

--spread:将中断移到指定的 CPU:

# tuna --irqs=128 --show_irqs # users affinity 128 iwlwifi 0,1,2,3 # tuna --irqs=128 --cpus=3 --move

使用 irq_list 参数替换 128,将 3 替换为 cpu_list 参数。

cpu_list 参数是一个用逗号分开的 CPU 号列表,例如

--cpus=0,2。如需更多信息,请参阅使用 tuna 工具调整 CPU。

验证步骤

在将任何中断移到特定的 CPU 之前和之后,比较所选 IRQs 的状态:

# tuna --irqs=128 --show_irqs # users affinity 128 iwlwifi 3

其他资源

-

/procs/interrupts文件 -

tuna (8)手册页

第 4 章 使用 RHEL 系统角色监控性能

作为系统管理员,您可以使用 metrics RHEL 系统角色监控系统性能。

4.1. 准备控制节点和受管节点以使用 RHEL 系统角色

在使用单独的 RHEL 系统角色管理服务和设置之前,您必须准备控制节点和受管节点。

4.1.1. 在 RHEL 9 上准备一个控制节点

使用 RHEL 系统角色前,您必须配置一个控制节点。然后,此系统根据 playbook 从清单中配置受管主机。

前提条件

- RHEL 8.6 或更高版本已安装。有关安装 RHEL 的更多信息,请参阅 执行标准的 RHEL 9 安装。

- 该系统已在客户门户网站中注册。

-

Red Hat Enterprise Linux Server订阅已附加到系统。 -

如果在客户门户网站帐户中可用,则

Ansible Automation Platform订阅被附加到系统。

流程

安装

rhel-system-roles软件包:[root@control-node]# dnf install rhel-system-roles此命令将

ansible-core软件包作为依赖项安装。注意在 RHEL 8.5 及更早版本中,Ansible 软件包通过 Ansible Engine 提供,而不是通过 Ansible Core ,并具有不同的支持级别。不要使用 Ansible Engine,因为软件包可能与 RHEL 8.6 及之后版本中的 Ansible 自动化内容不兼容。如需更多信息,请参阅 RHEL 9 和 RHEL 8.6 以及后期的 AppStream 存储库中包含的 Ansible Core 软件包的支持范围。

创建一个名为

ansible的用户,来管理并运行 playbook:[root@control-node]# useradd ansible切换到新创建的

ansible用户:[root@control-node]# su - ansible以这个用户身份执行其余步骤。

创建一个 SSH 公钥和私钥:

[ansible@control-node]$ ssh-keygen Generating public/private rsa key pair. Enter file in which to save the key (/home/ansible/.ssh/id_rsa): Enter passphrase (empty for no passphrase): <password> Enter same passphrase again: <password> ...

为密钥文件使用推荐的默认位置。

- 可选: 要防止 Ansible 在每次建立连接时提示您输入 SSH 密钥密码,请配置一个 SSH 代理。

使用以下内容创建

~/.ansible.cfg文件:[defaults] inventory = /home/ansible/inventory remote_user = ansible [privilege_escalation] become = True become_method = sudo become_user = root become_ask_pass = True

注意~/.ansible.cfg文件中的设置具有更高的优先级,并覆盖全局/etc/ansible/ansible.cfg文件中的设置。使用这些设置,Ansible 执行以下操作:

- 管理指定清单文件中的主机。

-

当帐户建立到受管节点的 SSH 连接时,使用

remote_user参数中设置的帐户。 -

使用

sudo工具,以root用户身份在受管节点上执行任务。 - 每次应用 playbook 时,都会提示输入远程用户的 root 密码。出于安全考虑,建议这样做。

创建一个列出受管主机主机名的 INI 或 YAML 格式的

~/inventory文件。您还可以在清单文件中定义主机组。例如,以下是 INI 格式的清单文件,它有三个主机,以及一个名为US的主机组:managed-node-01.example.com [US] managed-node-02.example.com ansible_host=192.0.2.100 managed-node-03.example.com

请注意,控制节点必须能够解析主机名。如果 DNS 服务器无法解析某些主机名,请在主机条目旁边添加

ansible_host参数来指定其 IP 地址。

后续步骤

- 准备受管节点。如需更多信息,请参阅 准备一个受管节点。

4.1.2. 准备受管节点

受管节点是在清单中列出的系统,它由控制节点根据 playbook 进行配置。您不必在受管主机上安装 Ansible。

前提条件

- 您已准备好了控制节点。如需更多信息,请参阅 在 RHEL 9 上准备一个控制节点。

您从控制节点进行 SSH 访问的权限。

重要以

root用户身份进行直接的 SSH 访问是一个安全风险。要降低这个风险,您将在此节点上创建一个本地用户,并在准备受管节点时配置一个sudo策略。然后,控制节点上的 Ansible 可以使用本地用户帐户登录到受管节点,并以不同的用户身份(如root)运行 playbook。

流程

创建一个名为

ansible的用户:[root@managed-node-01]# useradd ansible控制节点稍后使用这个用户建立与这个主机的 SSH 连接。

为

ansible用户设置密码:[root@managed-node-01]# passwd ansible Changing password for user ansible. New password: <password> Retype new password: <password> passwd: all authentication tokens updated successfully.

当 Ansible 使用

sudo以root用户身份执行任务时,您必须输入此密码。在受管主机上安装

ansible用户的 SSH 公钥:以

ansible用户身份登录到控制节点,并将 SSH 公钥复制到受管节点:[ansible@control-node]$ ssh-copy-id managed-node-01.example.com /usr/bin/ssh-copy-id: INFO: Source of key(s) to be installed: "/home/ansible/.ssh/id_rsa.pub" The authenticity of host 'managed-node-01.example.com (192.0.2.100)' can't be established. ECDSA key fingerprint is SHA256:9bZ33GJNODK3zbNhybokN/6Mq7hu3vpBXDrCxe7NAvo.

当提示时,输入

yes进行连接:Are you sure you want to continue connecting (yes/no/[fingerprint])? yes /usr/bin/ssh-copy-id: INFO: attempting to log in with the new key(s), to filter out any that are already installed /usr/bin/ssh-copy-id: INFO: 1 key(s) remain to be installed -- if you are prompted now it is to install the new keys当提示时,输入密码:

ansible@managed-node-01.example.com's password: <password> Number of key(s) added: 1 Now try logging into the machine, with: "ssh '<managed-node-01.example.com>'" and check to make sure that only the key(s) you wanted were added.

通过在控制节点上远程执行命令来验证 SSH 连接:

[ansible@control-node]$ ssh <managed-node-01.example.com> whoami ansible

为

ansible用户创建sudo配置:使用

visudo命令创建并编辑/etc/sudoers.d/ansible文件:[root@managed-node-01]# visudo /etc/sudoers.d/ansible在正常编辑器中使用

visudo的好处是,该实用程序提供基本的健全检查和检查是否有解析错误,然后再安装该文件。在

/etc/sudoers.d/ansible文件中配置满足您要求的sudoers策略,例如:要为

ansible用户授予权限,以便在输入ansible用户密码后在此主机上以任何用户和组身份来运行所有命令,请使用:ansible ALL=(ALL) ALL要向

ansible用户授予权限,以便在不输入ansible用户密码的情况下在该主机上以任何用户和组身份来运行所有命令,请使用:ansible ALL=(ALL) NOPASSWD: ALL

或者,配置匹配您安全要求的更精细的策略。有关

sudoers策略的详情,请查看sudoers (5)手册页。

验证

验证您可以在所有受管节点上执行来自控制节点的命令:

[ansible@control-node]$ ansible all -m ping BECOME password: <password> managed-node-01.example.com | SUCCESS => { "ansible_facts": { "discovered_interpreter_python": "/usr/bin/python3" }, "changed": false, "ping": "pong" } ...

硬编码的所有组会动态包含清单文件中列出的所有主机。

使用 Ansible

command模块在受管主机上运行whoami工具来验证特权升级是否可以正常工作:[ansible@control-node]$ ansible managed-node-01.example.com -m command -a whoami BECOME password: <password> managed-node-01.example.com | CHANGED | rc=0 >> root

如果命令返回 root,则您在受管节点上正确地配置了

sudo。

其他资源

- 在 RHEL 9 上准备一个控制节点。

-

sudoers (5)手册页

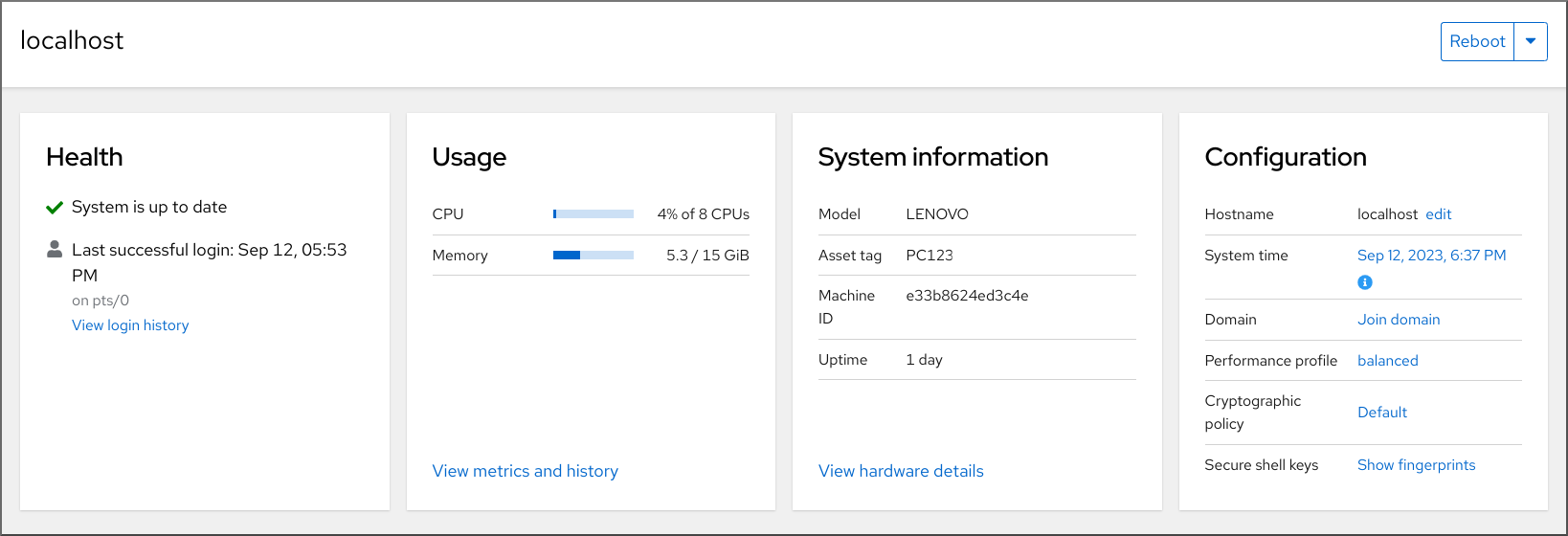

4.2. metrics 系统角色简介

RHEL 系统角色是 Ansible 角色和模块的集合,可为远程管理多个 RHEL 系统提供一致的配置界面。metrics 系统角色为本地系统配置性能分析服务,并可以选择包含要由本地系统监控的远程系统的列表。metrics 系统角色可让您使用 pcp 来监控系统性能,而无需单独配置 pcp,因为 playbook 处理 pcp 的设置和部署。

表 4.1. metrics 系统角色变量

| 角色变量 | 描述 | 用法示例 |

|---|---|---|

| metrics_monitored_hosts |

要通过目标主机分析的远程主机的列表。这些主机将在目标主机上记录指标,因此要确保每个主机的 |

|

| metrics_retention_days | 在删除前配置性能数据保留的天数。 |

|

| metrics_graph_service |

一个布尔值标志,使主机能够通过 |

|

| metrics_query_service |

一个布尔值标志,使主机能够通过 |

|

| metrics_provider |

指定要用于提供指标的指标收集器。目前, |

|

| metrics_manage_firewall |

使用 |

|

| metrics_manage_selinux |

使用 |

|

如需有关 metrics_connections 中使用的参数,以及有关 metrics 系统角色的其他信息,请参阅 /usr/share/ansible/roles/rhel-system-roles.metrics/README.md 文件。

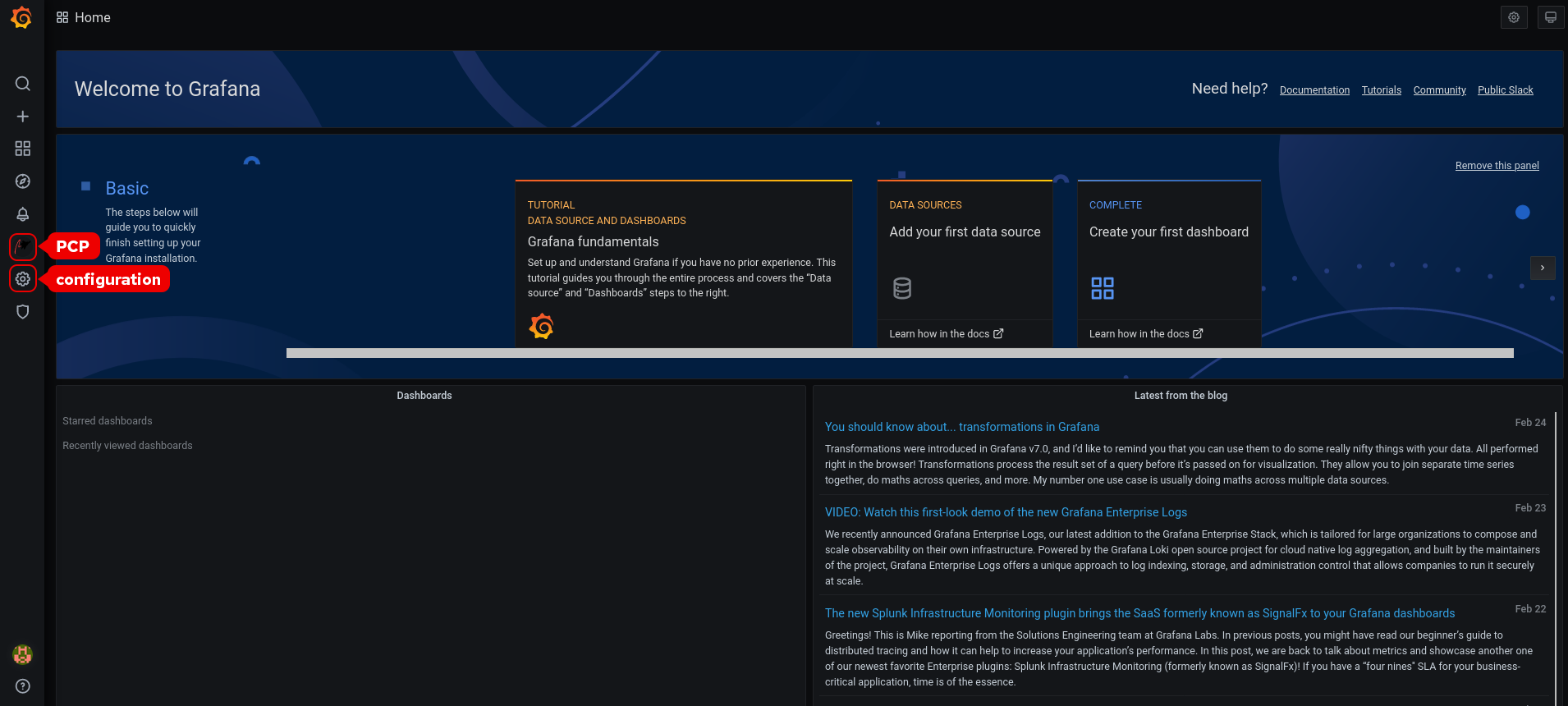

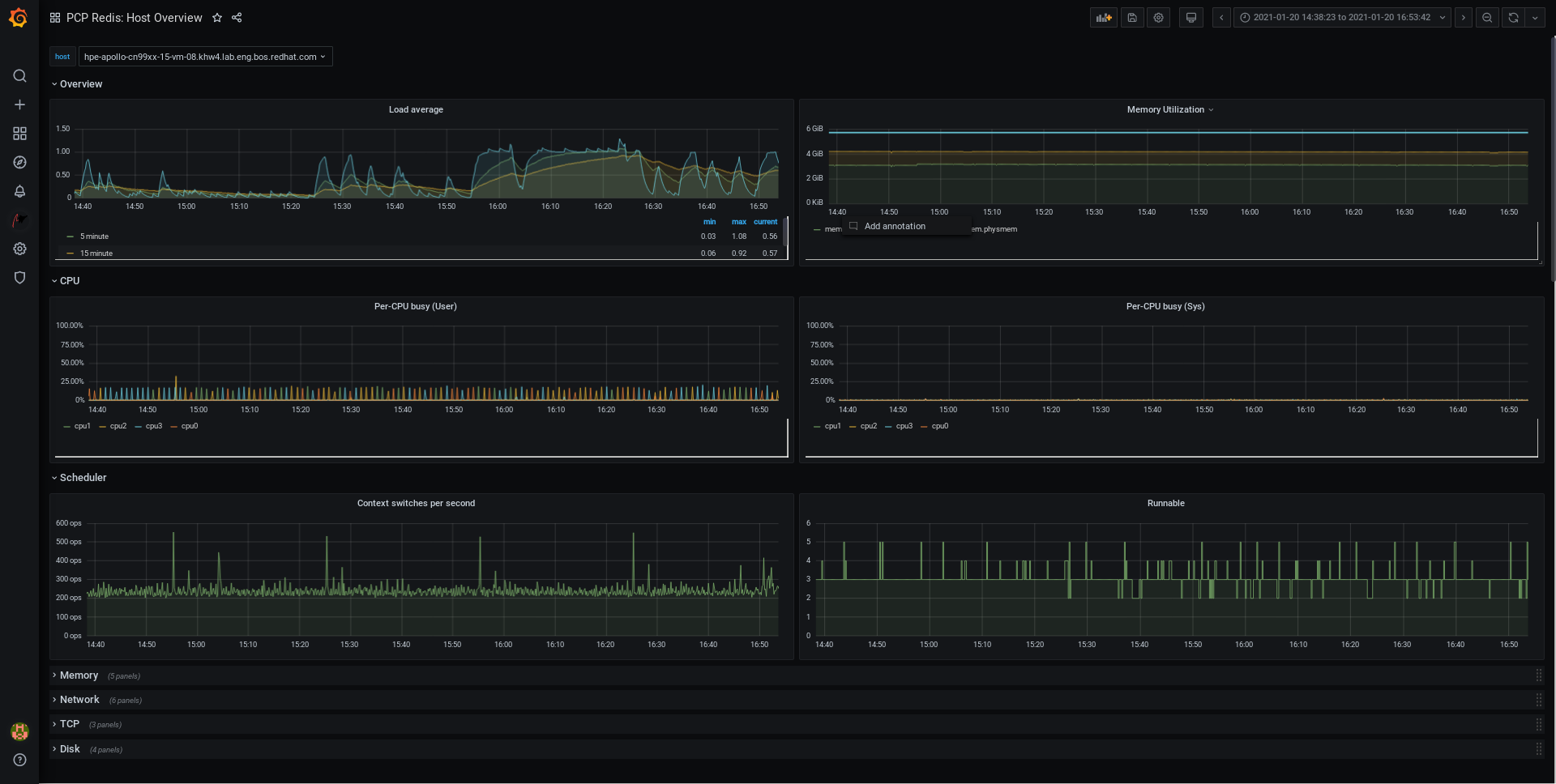

4.3. 使用 metrics 系统角色以可视化方式监控本地系统

此流程描述了如何使用 metrics RHEL 系统角色来监控您的本地系统,同时通过 Grafana 提供数据可视化。

前提条件

- Ansible Core 软件包安装在控制机器上。

-

您已在要监控的机器上安装了

rhel-system-roles软件包。

流程

通过在清单中添加以下内容,在

/etc/ansible/hostsAnsible 清单中配置localhost:localhost ansible_connection=local

使用以下内容创建一个 Ansible playbook:

--- - name: Manage metrics hosts: localhost vars: metrics_graph_service: yes metrics_manage_firewall: true metrics_manage_selinux: true roles: - rhel-system-roles.metrics运行 Ansible playbook:

# ansible-playbook name_of_your_playbook.yml注意因为

metrics_graph_service布尔值被设置为value="yes",所以Grafana会被自动安装,并使用pcp置备为数据源。因为metrics_manage_firewall和metrics_manage_selinux都被设为了true,所以 metrics 角色使用firewall和selinux系统角色来管理 metrics 角色使用的端口。-

要查看机器上收集的指标的视图,请访问

grafanaweb界面 ,如 访问 Grafana web UI 中所述。

4.4. 使用 metrics 系统角色来建立一组单独的系统来监视它们自己

此流程描述了如何使用 metrics 系统角色设置一组机器来监控其自身。

前提条件

- Ansible Core 软件包安装在控制机器上。

-

您已在要用来运行 playbook 的机器上安装了

rhel-system-roles软件包。 - 您已建立 SSH 连接。

步骤

将您要通过 playbook 监控的机器的名称或 IP 地址添加到

/etc/ansible/hostsAnsible 清单文件中,在括号括起的标识组名称下:[remotes] webserver.example.com database.example.com

使用以下内容创建一个 Ansible playbook:

--- - hosts: remotes vars: metrics_retention_days: 0 metrics_manage_firewall: true metrics_manage_selinux: true roles: - rhel-system-roles.metrics注意因为

metrics_manage_firewall和metrics_manage_selinux都被设为了true,所以 metrics 角色使用firewall和selinux角色来管理metrics角色使用的端口。运行 Ansible playbook:

# ansible-playbook name_of_your_playbook.yml -k其中

-k提示连接到远程系统的密码。

4.5. 使用 metrics 系统角色通过本地机器监控机器的数量

此流程描述了如何使用 metrics 系统角色设置本地机器来集中一组监控机器,同时通过 grafana 提供数据的可视化,并通过 redis 提供数据的查询。

前提条件

- Ansible Core 软件包安装在控制机器上。

-

您已在要用来运行 playbook 的机器上安装了

rhel-system-roles软件包。

步骤

使用以下内容创建一个 Ansible playbook:

--- - hosts: localhost vars: metrics_graph_service: yes metrics_query_service: yes metrics_retention_days: 10 metrics_monitored_hosts: ["database.example.com", "webserver.example.com"] metrics_manage_firewall: yes metrics_manage_selinux: yes roles: - rhel-system-roles.metrics运行 Ansible playbook:

# ansible-playbook name_of_your_playbook.yml注意因为

metrics_graph_service和metrics_query_service布尔值被设置为了value="yes",所以grafana会被自动安装,并使用pcp置备为数据源,并将pcp数据记录索引到redis中,允许pcp查询语言用于复杂的数据查询。因为metrics_manage_firewall和metrics_manage_selinux都被设为了true,所以metrics角色使用firewall和selinux角色来管理metrics角色使用的端口。-

要查看机器集中收集的指标的图形表示,并查询数据,请访问

grafanaweb 界面,如 访问 Grafana Web UI 中所述。

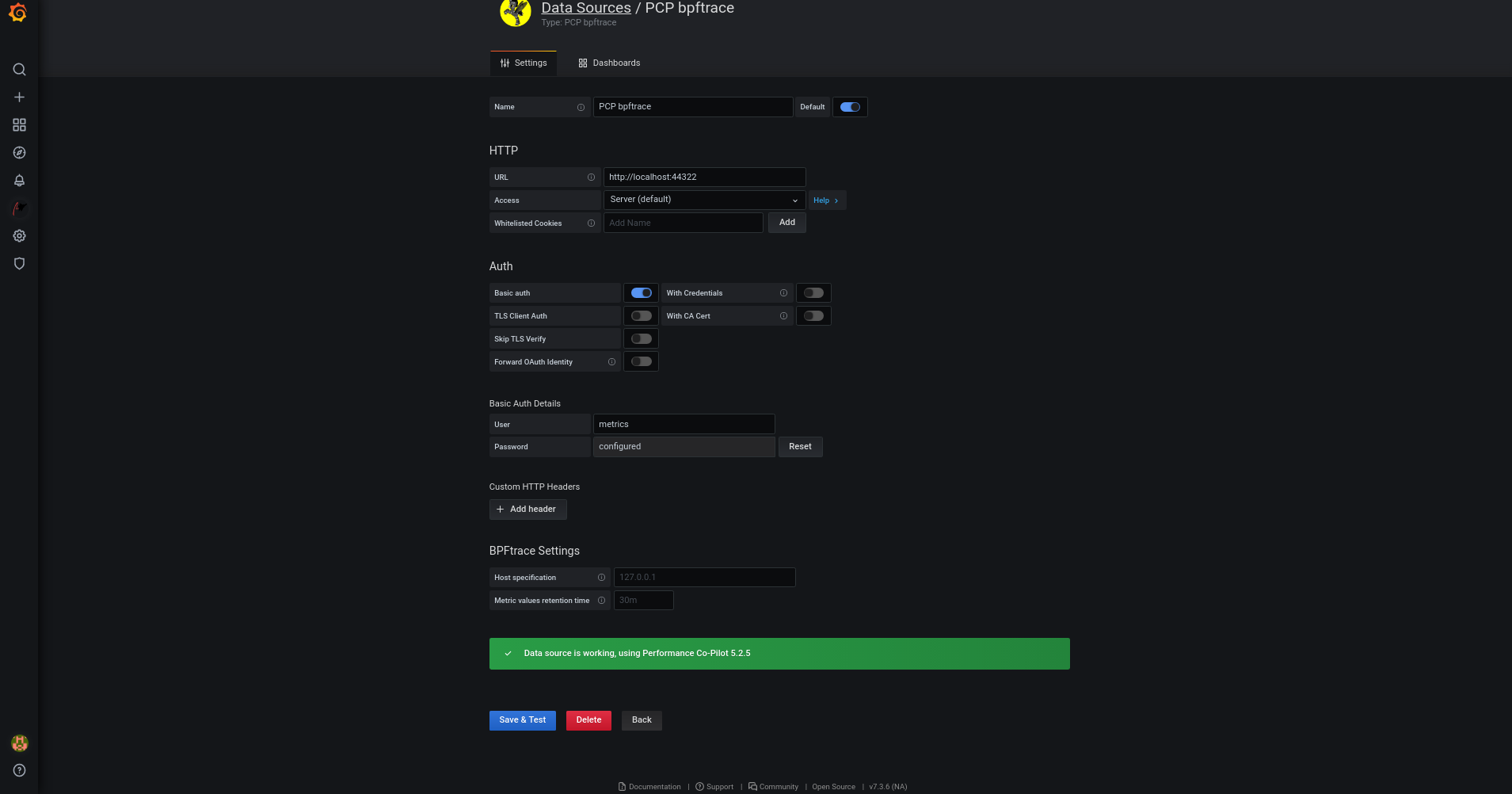

4.6. 在使用 metrics 系统角色监控系统时设置身份验证

PCP 通过简单身份验证安全层 (SASL) 框架支持 scram-sha-256 验证机制。metrics RHEL 系统角色使用 scram-sha-256 身份验证机制自动设置身份验证的步骤。这个步骤描述了如何使用 metrics RHEL 系统角色设置身份验证。

前提条件

- Ansible Core 软件包安装在控制机器上。

-

您已在要用来运行 playbook 的机器上安装了

rhel-system-roles软件包。

步骤

在您要为其设置身份验证的 Ansible playbook 中包含以下变量:

--- vars: metrics_username: your_username metrics_password: your_password metrics_manage_firewall: true metrics_manage_selinux: true注意因为

metrics_manage_firewall和metrics_manage_selinux都被设为了true,所以metrics角色使用firewall和selinux角色来管理metrics角色使用的端口。运行 Ansible playbook:

# ansible-playbook name_of_your_playbook.yml

验证步骤

验证

sasl配置:# pminfo -f -h "pcp://ip_adress?username=your_username" disk.dev.read Password: disk.dev.read inst [0 or "sda"] value 19540

ip_adress 应替换为主机的 IP 地址。

4.7. 使用 metrics 系统角色为 SQL Server 配置并启用指标集合

此流程描述了如何使用 metrics RHEL 系统角色通过您本地系统中的 pcp 自动配置和为 Microsoft SQL Server 启用指标集合。

前提条件

- Ansible Core 软件包安装在控制机器上。

-

您已在要监控的机器上安装了

rhel-system-roles软件包。 - 您已安装了用于 Red Hat Enterprise Linux 的 Microsoft SQL Server,并建立了与 SQL 服务器的"信任"连接。请参阅安装 SQL Server 并在红帽上创建数据库。

- 您已为 Red Hat Enterprise Linux 安装了用于 SQL Server 的 Microsoft ODBC 驱动程序。请参阅 Red Hat Enterprise Server 和 Oracle Linux。

流程

通过在清单中添加以下内容,在

/etc/ansible/hostsAnsible 清单中配置localhost:localhost ansible_connection=local

创建一个包含以下内容的 Ansible playbook:

--- - hosts: localhost vars: metrics_from_mssql: true metrics_manage_firewall: true metrics_manage_selinux: true roles: - role: rhel-system-roles.metrics

注意因为

metrics_manage_firewall和metrics_manage_selinux都被设为了true,所以metrics角色使用firewall和selinux角色来管理metrics角色使用的端口。运行 Ansible playbook:

# ansible-playbook name_of_your_playbook.yml

验证步骤

使用

pcp命令来验证 SQL Server PMDA 代理 (mssql) 是否已加载并在运行:# pcp platform: Linux rhel82-2.local 4.18.0-167.el8.x86_64 #1 SMP Sun Dec 15 01:24:23 UTC 2019 x86_64 hardware: 2 cpus, 1 disk, 1 node, 2770MB RAM timezone: PDT+7 services: pmcd pmproxy pmcd: Version 5.0.2-1, 12 agents, 4 clients pmda: root pmcd proc pmproxy xfs linux nfsclient mmv kvm mssql jbd2 dm pmlogger: primary logger: /var/log/pcp/pmlogger/rhel82-2.local/20200326.16.31 pmie: primary engine: /var/log/pcp/pmie/rhel82-2.local/pmie.log

第 5 章 设置 PCP

Performance Co-Pilot (PCP) 是用于监控、视觉化、存储和分析系统级性能测量的工具、服务和库集。

5.1. PCP 概述

您可以使用 Python、Perl、C++ 和 C 接口添加性能指标。分析工具可以直接使用 Python、C++、C 客户端 API,并通过 JSON 界面探索所有可用的性能数据。

您可以通过将实时结果与存档数据进行比较来分析数据模型。

PCP 的功能:

- 轻量级分布式架构,在复杂的系统集中分析过程中非常有用。

- 它允许监控和管理实时数据。

- 它允许记录和检索历史数据。

PCP 包含以下组件:

-

Performance Metric Collector Daemon (

pmcd) 从已安装的性能指标域代理 (pmda) 收集性能数据。PMDA 可以单独加载或卸载在系统上,并由同一主机上的 PMCD 控制。 -

pminfo或pmstat等各种客户端工具可以检索、显示、存档和处理同一主机或网络上的此数据。 -

pcp软件包提供命令行工具和底层功能。 -

pcp-gui软件包提供了图形应用程序。执行dnf install pcp-gui命令安装pcp-gui软件包。如需更多信息,请参阅使用 PCP Charts 应用程序进行 Visual tracing PCP 日志归档。

其他资源

-

pcp (1)手册页 -

/usr/share/doc/pcp-doc/directory - PCP 分发的系统服务和工具

- Performance Co-Pilot (PCP) 文章、解决方案、教程以及红帽客户门户网站中的白皮书的索引

- PCP 工具与旧工具红帽知识库文章的并排比较

- PCP 上游文档

5.2. 安装并启用 PCP

要开始使用 PCP,请安装所有必需的软件包并启用 PCP 监控服务。

这个步骤描述了如何使用 pcp 软件包安装 PCP。如果要自动化 PCP 安装,请使用 pcp-zeroconf 软件包安装它。有关使用 pcp-zeroconf 安装 PCP 的更多信息,请参阅 使用 pcp-zeroconf 设置 PCP。

步骤

安装

pcp软件包:# dnf install pcp

在主机机器上启用并启动

pmcd服务:# systemctl enable pmcd # systemctl start pmcd

验证步骤

验证

pmcd进程是否在主机上运行:# pcp Performance Co-Pilot configuration on workstation: platform: Linux workstation 4.18.0-80.el8.x86_64 #1 SMP Wed Mar 13 12:02:46 UTC 2019 x86_64 hardware: 12 cpus, 2 disks, 1 node, 36023MB RAM timezone: CEST-2 services: pmcd pmcd: Version 4.3.0-1, 8 agents pmda: root pmcd proc xfs linux mmv kvm jbd2

其他资源

-

pmcd (1)man page - PCP 分发的系统服务和工具

5.3. 部署最小 PCP 设置

PCP 最小设置收集 Red Hat Enterprise Linux 的性能统计信息。设置涉及在产品系统中添加收集数据以便进一步分析所需的最小软件包数量。

您可以使用各种 PCP 工具分析生成的 tar.gz 文件和 pmlogger 输出存档,并将它们与其他性能信息源进行比较。

先决条件

- 已安装 PCP。如需更多信息,请参阅安装并启用 PCP。

步骤

更新

pmlogger配置:# pmlogconf -r /var/lib/pcp/config/pmlogger/config.default

启动

pmcd和pmlogger服务:# systemctl start pmcd.service # systemctl start pmlogger.service

- 执行所需的操作来记录性能数据。

停止

pmcd和pmlogger服务:# systemctl stop pmcd.service # systemctl stop pmlogger.service

保存输出并将其保存到基于主机名和当前日期和时间的

tar.gz文件中:# cd /var/log/pcp/pmlogger/ # tar -czf $(hostname).$(date +%F-%Hh%M).pcp.tar.gz $(hostname)

使用 PCP 工具提取此文件并分析数据。

其他资源

-

pmlogconf (1) 、pmlogger (1)和pmcd (1)man page - PCP 分发的系统服务和工具

5.4. PCP 分发的系统服务和工具

Performance Co-Pilot (PCP)包括可用来测量性能的各种系统服务和工具。基本软件包 pcp 包括系统服务和基本工具。pcp-system-tools、pcp-gui 和 pcp-devel 软件包提供了其他工具。

PCP 分发的系统服务的角色

pmcd- Performance Metric Collector Daemon (PMCD) 。

pmie- 性能指标对引擎.

pmlogger- 性能指标日志记录器。

pmproxy- 实时和历史性能指标代理、时间序列查询和 REST API 服务。

基本 PCP 软件包分发的工具

pcp- 显示 Performance Co-Pilot 安装的当前状态。

pcp-vmstat- 每 5 秒提供高级系统性能概述。显示有关进程、内存、分页、块 IO、 traps 和 CPU 活动的信息。

pmconfig- 显示配置参数的值。

pmdiff- 比较一个或两个存档(给定时间窗内)中每个指标的平均值,而在搜索性能回归时可能会感兴趣的更改。

pmdumplog- 显示 Performance Co-Pilot 归档文件中的控制、元数据、索引和状态信息。

pmfind- 在网络上查找 PCP 服务。

pmie- 定期评估一组算术、逻辑和规则表达式的 inference 引擎。指标可以从 live 系统或 Performance Co-Pilot 归档文件收集。

pmieconf-

显示或设置可配置的

pmie变量。 pmiectl-

管理

pmie的非主要实例。 pminfo- 显示性能指标的相关信息。指标可以从 live 系统或 Performance Co-Pilot 归档文件收集。

pmlc-

交互式配置活动的

pmlogger实例。 pmlogcheck- 在 Performance Co-Pilot 归档文件中标识无效数据。

pmlogconf-

创建和修改

pmlogger配置文件。 pmlogctl-

管理

pmlogger的非主要实例。 pmloglabel- 验证、修改或修复 Performance Co-Pilot 归档文件的标签。

pmlogsummary- 计算 Performance Co-Pilot 归档文件中存储性能指标的统计信息。

pmprobe- 决定性能指标的可用性。

pmsocks- 允许通过防火墙访问 Performance Co-Pilot 主机。

pmstat- 定期显示系统性能的简短摘要。

pmstore- 修改性能指标的值。

pmtrace- 提供到 trace PMDA 的命令行界面。

pmval- 显示性能指标的当前值。

单独安装的 pcp-system-tools 软件包分发的工具

pcp-atop- 从性能角度显示最重要的硬件资源的系统级别:CPU、内存、磁盘和网络。

pcp-atopsar-

在各种系统资源使用率上生成系统级活动报告。报告从之前使用

pmlogger或pcp-atop的-w选项记录的原始日志文件生成。 pcp-dmcache- 显示有关配置的设备映射缓存目标的信息,例如:设备 IOP、缓存和元数据设备利用率,以及在每次缓存设备的读写率和比率。

pcp-dstat-

一次显示一个系统的指标。要显示多个系统的指标,请使用

--host选项。 pcp-free- 报告系统中的空闲和已用内存。

pcp-htop-

以类似于

top命令的方式显示系统上运行的所有进程及其命令行参数,但允许您使用鼠标进行垂直和水平滚动。您还可以以树形格式查看进程,并同时对多个进程选择和实施。 pcp-ipcs- 显示有关调用进程具有读取访问权限的进程间通信(IPC)工具的信息。

pcp-mpstat- 报告 CPU 和与中断相关的统计信息。

pcp-numastat- 显示内核内存分配器的 NUMA 分配统计信息。

pcp-pidstat- 显示系统上运行的各个任务或进程的信息,如 CPU 百分比、内存和堆栈使用率、调度和优先级。报告默认情况下本地主机的实时数据。

pcp-shping-

pmdashping性能指标域代理(PMDA)导出的有关 shell-ping 服务指标的样本和报告。 pcp-ss-

显示

pmdasocketsPMDA 收集的套接字统计信息。 pcp-tapestat- 报告磁带设备的 I/O 统计信息。

pcp-uptime- 显示系统正在运行的时长,当前登录的用户数量,以及过去 1、5 和 15 分钟的系统负载平均值。

pcp-verify- 检查 Performance Co-Pilot 收集器安装的各个方面,并报告其是否为某些操作模式进行了正确配置。

pmiostat-

报告 SCSI 设备(默认)或设备映射器设备的 I/O 统计信息(使用

-xdevice-mapper 选项)。 pmrep- 报告选定、易于自定义、性能指标值。

单独安装的 pcp-gui 软件包分发的工具

pmchart- 通过 Performance Co-Pilot 的功能来绘制性能指标值。

pmdumptext- 输出从 Performance Co-Pilot 归档收集的性能指标值。

单独安装的 pcp-devel 软件包分发的工具

pmclient- 使用性能指标应用程序编程接口 (PMAPI) 显示高级系统性能指标。

pmdbg- 显示可用的 Performance Co-Pilot 调试控制标记及其值。

pmerr- 显示可用的 Performance Co-Pilot 错误代码及其对应的错误消息。

5.5. PCP 部署架构

Performance Co-Pilot (PCP)根据 PCP 部署规模,支持多个部署架构,并提供许多选项来完成高级设置。

可用的扩展部署设置变体基于红帽推荐的部署设置、调整因素和配置选项,包括:

Localhost每个服务在被监控的机器上本地运行。当您在没有配置更改的情况下启动服务时,这是默认的部署。在这种情况下无法对单个节点进行扩展。

默认情况下,Redis 的部署设置是单机 localhost。但是,Red Hat Redis 可以选择以高可用性和高度扩展的集群执行,其中数据在多个主机之间共享。另一个可行选择是在云中部署 Redis 集群,或者从云供应商中使用受管 Redis 集群。

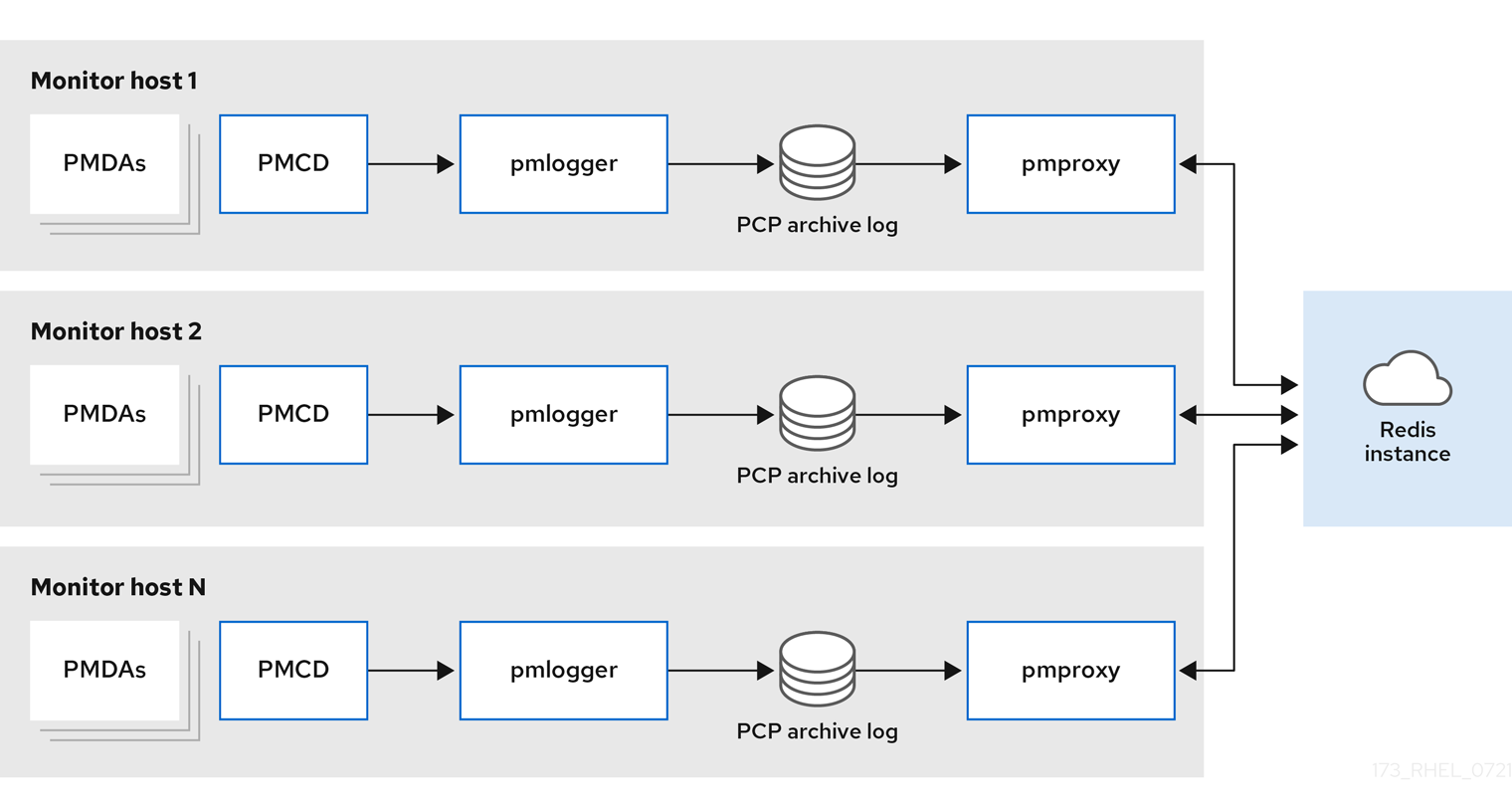

Decentralizedlocalhost 和分散设置之间的唯一区别是集中式 Redis 服务。在这种模型中,主机在每个被监控的主机上执行

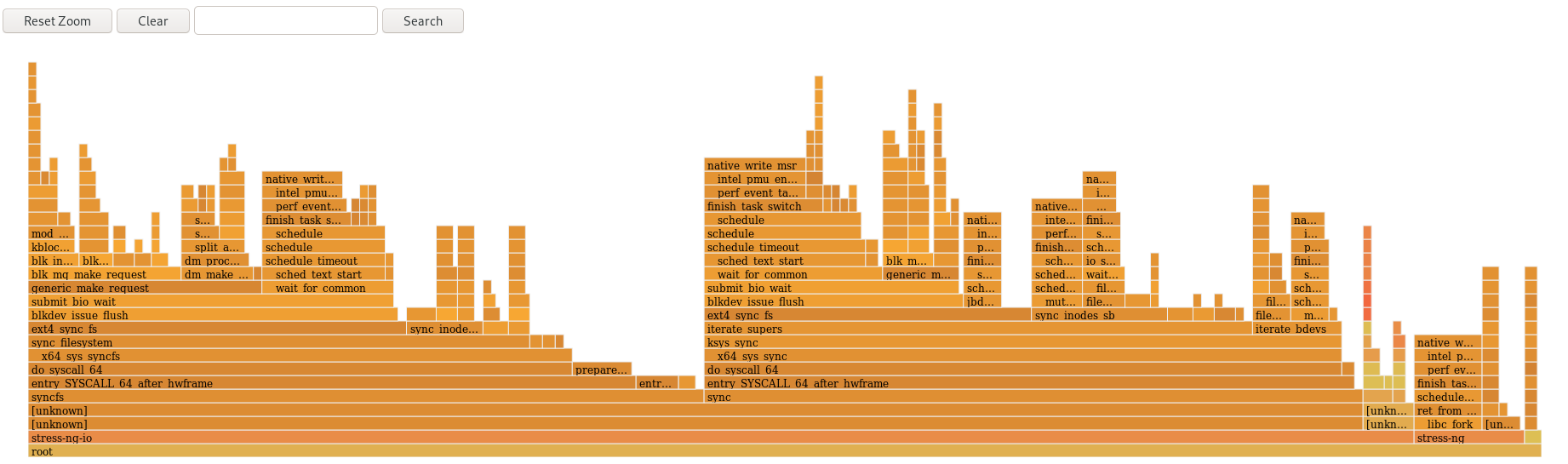

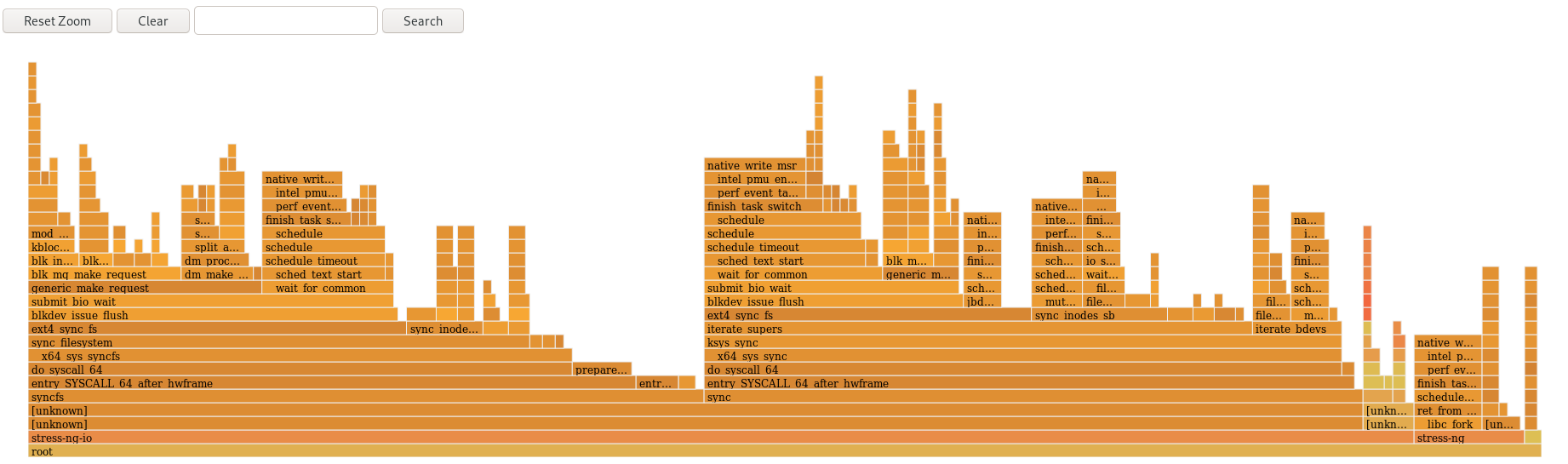

pmlogger服务,并从本地pmcd实例检索指标。然后本地pmproxy服务将性能指标导出到中央 Redis 实例。图 5.1. 分散日志记录

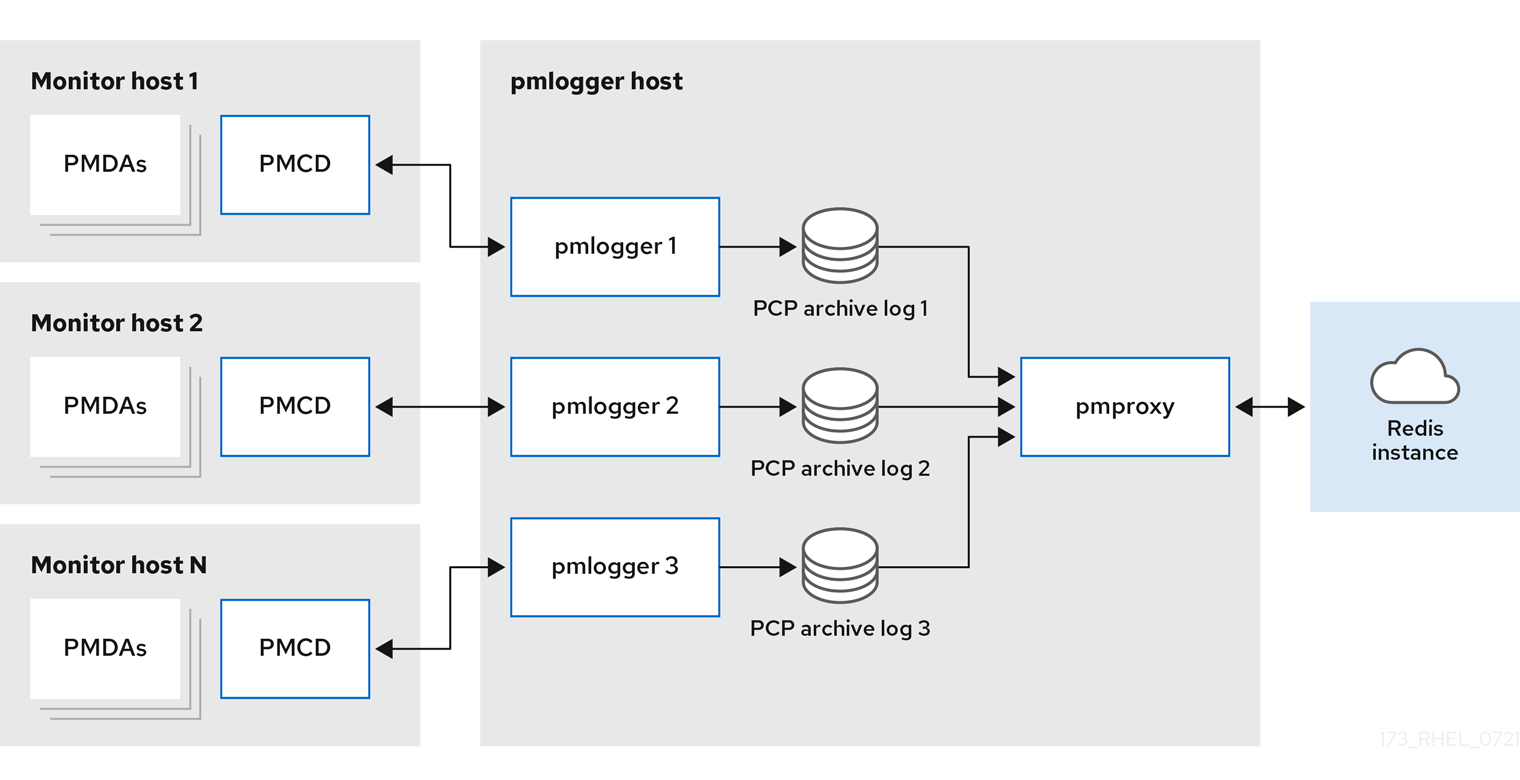

集中式日志记录 - pmlogger 场当被监控主机的资源使用情况受限时,另一个部署选项是一个

pmlogger场,也称为集中式日志记录。在本设置中,单个日志记录器主机执行多个pmlogger进程,各自配置为从不同的远程pmcd主机检索性能指标。集中式日志记录器主机也被配置为执行pmproxy服务,该服务发现生成的 PCP 存档日志并将指标数据加载到 Redis 实例中。图 5.2. 集中式日志记录 - pmlogger 场

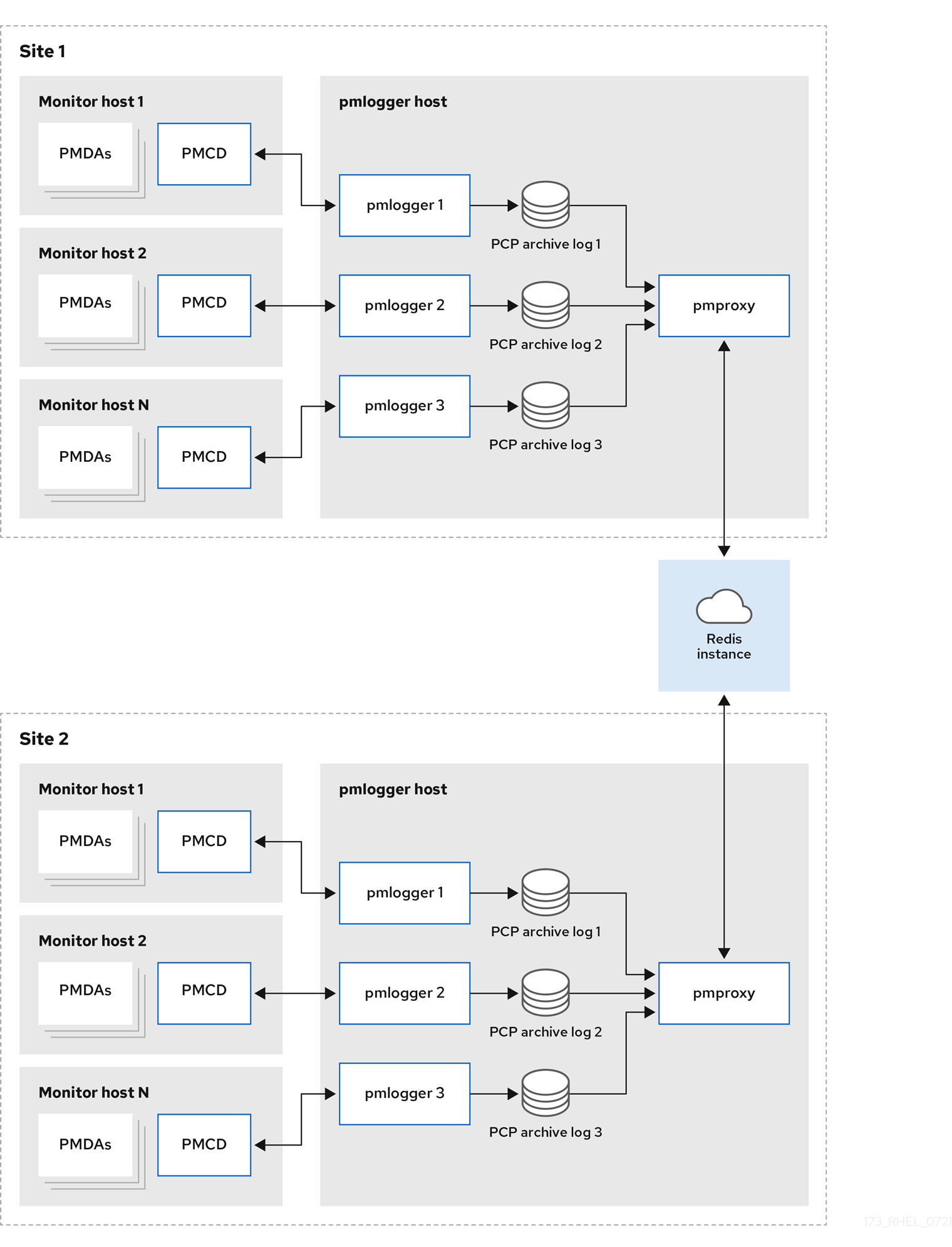

联邦 - 多个 pmlogger farms对于大规模部署,红帽建议以联邦方式部署多个

pmloggerfarm。例如,每个机架或数据中心一个pmloggerfarm。每个pmloggerfarm 都会将指标加载到中央 Redis 实例中。图 5.3. 联邦 - 多个 pmlogger farms

默认情况下,Redis 的部署设置是单机 localhost。但是,Red Hat Redis 可以选择以高可用性和高度扩展的集群执行,其中数据在多个主机之间共享。另一个可行选择是在云中部署 Redis 集群,或者从云供应商中使用受管 Redis 集群。

其他资源

-

pcp (1),pmlogger (1),pmproxy (1), 和pmcd (1)man pages - 推荐的部署架构

5.6. 推荐的部署架构

下表根据监控的主机数量描述了推荐的部署架构。

表 5.1. 推荐的部署架构

| 主机数 (N) | 1-10 | 10-100 | 100-1000 |

|---|---|---|---|

|

| N | N | N |

|

| 1 到 N | N/10 到 N | N/100 到 N |

|

| 1 到 N | 1 到 N | N/100 到 N |

| Redis 服务器 | 1 到 N | 1 到 N/10 | N/100 到 N/10 |

| Redis 集群 | 否 | Maybe | 是 |

| 推荐的部署设置 | localhost、Decentralized 或 centralized logging | Decentralized, Centralized logging 或 Federated | decentralized 或 Federated |

5.7. 大小考虑因素

以下是扩展所需的大小调整因素:

远程系统大小-

CPU、磁盘、网络接口和其他硬件资源的数量会影响中央日志记录主机上的每个

pmlogger收集的数据量。 日志记录的指标数据-

日志记录的指标的数量和类型是重要的角色。特别是,

per-process proc.*指标需要大量磁盘空间,例如,标准pcp-zeroconf设置、10s 日志记录间隔、11 MB、没有 proc 指标和 155 MB 的 proc 指标 - 可获得 10 倍。此外,每个指标的实例数量,如 CPU、块设备和网络接口的数量也会影响所需的存储容量。 日志记录间隔-

指标的日志记录频率,会影响存储要求。预期的每日 PCP 归档文件大小会为每个

pmlogger实例写入到pmlogger.log文件。这些值未压缩估算。由于 PCP 归档的压缩非常大,大约 10:1,因此可以为特定站点确定实际的长期磁盘空间要求。 pmlogrewrite-

在每个 PCP 升级后,将执行

pmlogrewrite工具,并重写旧的归档(如果之前版本中的指标元数据有变化)和 PCP 的新版本。这个过程持续时间使用存储的存档数扩展线性。

其他资源

-

pmlogrewrite (1)和pmlogger (1)man page

5.8. PCP 扩展的配置选项

以下是扩展所需的配置选项:

sysctl 和 rlimit 设置-

当启用归档发现时,对于每个

pmlogger,pmproxy都需要 4 个描述符,用于监控或注销,以及服务日志和pmproxy客户端套接字的额外文件描述符(如果有)。每个pmlogger进程在远程pmcd套接字、存档文件、服务日志等中使用大约 20 个文件描述符。总的来说,这可以超过运行约 200 个pmlogger进程的系统上的默认 1024 软限制。pcp-5.3.0及之后的版本中的pmproxy服务会自动将软限制增加到硬限制。在 PCP 的早期版本中,如果要部署大量pmlogger进程,则需要调优;这可以通过增加pmlogger的软或硬限制来实现。如需更多信息,请参阅 如何为 systemd 运行的服务设置限制 (ulimit) 。 本地归档-

pmlogger服务将本地和远程pmcds的指标存储在/var/log/pcp/pmlogger/目录中。要控制本地系统的日志间隔,请更新/etc/pcp/pmlogger/control.d/configfile文件,并在参数中添加-t X,其中 X 是日志间隔(以秒为单位)。要配置应该记录哪些指标,请执行pmlogconf /var/lib/pcp/config/pmlogger/config.clienthostname。此命令使用一组默认指标来部署配置文件,可选择性地进行进一步自定义。要指定保留设置(指定何时清除旧的 PCP 存档),更新/etc/sysconfig/pmlogger_timers文件指定PMLOGGER_DAILY_PARAMS="-E -k X",其中 X 是保留 PCP 归档的天数。 Redispmproxy服务将日志记录的指标从pmlogger发送到 Redis 实例。以下是两个选项,用于指定/etc/pcp/pmproxy/pmproxy.conf配置文件中的保留设置:-

stream.expire指定应删除过时指标时的持续时间,即在指定时间内没有更新的指标,以秒为单位。 -

stream.maxlen指定每个主机的一个指标值的最大指标值数。此设置应是保留的时间除以日志间隔,例如如果保留时间为 14 天日志间隔是 60s,则设置为 20160 (60*60*24*14/60)

-

其他资源

-

pmproxy (1),pmlogger (1), 和sysctl (8)man pages

5.9. 示例:分析集中式日志记录部署

在集中式日志记录设置中收集以下结果(也称为 pmlogger 场部署),其默认 pcp-zeroconf 5.3.0 安装,其中每个远程主机都是在有 64 个 CPU 内核、376 GB RAM 的服务器上运行 pmcd 的相同容器实例。

日志记录间隔为 10s,不包含远程节点的 proc 指标,内存值则引用 Resident Set Size (RSS) 值。

表 5.2. 10s 日志间隔的详细利用率统计

| 主机数量 | 10 | 50 |

|---|---|---|

| PCP 每天归档存储 | 91 MB | 522 MB |

|

| 160 MB | 580 MB |

|

每天 | 2 MB | 9 MB |

|

| 1.4 GB | 6.3 GB |

| 每天的 redis 内存 | 2.6 GB | 12 GB |

表 5.3. 根据被监控的主机提供 60 个日志记录间隔的资源

| 主机数量 | 10 | 50 | 100 |

|---|---|---|---|

| PCP 每天归档存储 | 20 MB | 120 MB | 271 MB |

|

| 104 MB | 524 MB | 1049 MB |

|

每天 | 0.38 MB | 1.75 MB | 3.48 MB |

|

| 2.67 GB | 5.5GB | 9 GB |

| 每天的 redis 内存 | 0.54 GB | 2.65 GB | 5.3 GB |

pmproxy 队列 Redis 请求,并使用 Redis pipelining 来加快 Redis 查询。这可能导致大量内存使用。有关此问题的故障排除,请参阅对高内存的使用进行故障排除。

5.10. 示例:分析联合设置部署

以下结果在联合设置中观察,也称为多个 pmlogger farm,由三个集中式日志记录(pmlogger farm)设置组成,每个 pmlogger farm 都监控 100 个远程主机,总计为 300 个主机。

pmlogger 场的设置与下面提到的配置一样

60s 日志记录间隔的 示例:分析集中式日志记录部署 ,但 Redis 服务器在集群模式下运行。

表 5.4. 根据联合主机进行 60s 日志记录间隔使用的资源

| PCP 每天归档存储 | pmlogger Memory | 每天网络 (In/Out) | pmproxy Memory | 每天的 redis 内存 |

|---|---|---|---|---|

| 277 MB | 1058 MB | 15.6 MB / 12.3 MB | 6-8 GB | 5.5 GB |

此处,所有值都是每个主机。网络带宽较高,因为 Redis 集群的节点间通信。

5.11. 建立安全的 PCP 连接

您可以配置 PCP 收集器和监控组件,以参与安全的 PCP 协议交换。

5.11.1. 确保 PCP 连接安全

您可以在 Performance Co-Pilot (PCP)收集器和监控组件之间建立安全连接。PCP 收集器组件是 PCP 的一部分,它从不同的源收集和提取性能数据。PCP 监控组件是 PCP 的一部分,它显示从安装了 PCP 收集器组件的主机或存档中收集来的数据。在这些组件之间建立安全连接有助于防止未授权方访问或修改正在收集和监控的数据。

所有与性能指标收集器守护进程(pmcd)的连接都是使用基于 TCP/IP 的 PCP 协议建立的。协议代理和 PCP REST API 由 pmproxy 守护进程提供 - REST API 可通过 HTTPS 访问,以确保安全连接。

pmcd 和 pmproxy 守护进程能够在单一端口上同时进行 TLS 和非 TLS 通信。pmcd 的默认端口是 44321 ,44322 用于 pmproxy。这意味着您不必为您的 PCP 收集器系统在 TLS 或非 TLS 通信之间进行选择,您可以同时使用它们。

5.11.2. 为 PCP 收集器组件配置安全连接

所有 PCP 收集器系统必须有有效的证书,以便参与 PCP 协议交换。

从 TLS 的角度来看,pmproxy 守护进程同时作为客户端和服务器运行。

先决条件

- 已安装 PCP。如需更多信息,请参阅安装并启用 PCP。

私有客户端密钥存储在

/etc/pcp/tls/client.key文件中。如果您使用其他路径,请调整该流程的对应步骤。有关创建私钥和证书签名请求(CSR)的详细信息,以及如何从证书颁发机构(CA)请求证书,请参阅您的 CA 文档。

-

TLS 客户端证书存储在

/etc/pcp/tls/client.crt文件中。如果您使用其他路径,请调整该流程的对应步骤。 -

CA 证书存储在

/etc/pcp/tls/ca.crt文件中。如果您使用其他路径,请调整该流程的对应步骤。另外,对于pmproxy守护进程: -

私有服务器密钥存储在

/etc/pcp/tls/server.key文件中。如果您使用其他路径,请调整流程的相应步骤 -

TLS 服务器证书存储在

/etc/pcp/tls/server.crt文件中。如果您使用其他路径,请调整该流程的对应步骤。

步骤

更新收集器系统上的 PCP TLS 配置文件,以使用 CA 发布的证书来建立安全连接:

# cat > /etc/pcp/tls.conf << END tls-ca-cert-file = /etc/pcp/tls/ca.crt tls-key-file = /etc/pcp/tls/server.key tls-cert-file = /etc/pcp/tls/server.crt tls-client-key-file = /etc/pcp/tls/client.key tls-client-cert-file = /etc/pcp/tls/client.crt END

重启 PCP 收集器基础架构:

# systemctl restart pmcd.service # systemctl restart pmproxy.service

验证

验证 TLS 配置:

在

pmcd服务上:# grep 'Info:' /var/log/pcp/pmcd/pmcd.log [Tue Feb 07 11:47:33] pmcd(6558) Info: OpenSSL 3.0.7 setup

在

pmproxy服务上:# grep 'Info:' /var/log/pcp/pmproxy/pmproxy.log [Tue Feb 07 11:44:13] pmproxy(6014) Info: OpenSSL 3.0.7 setup

5.11.3. 为 PCP 监控组件配置安全连接

配置 PCP 监控组件以参与安全 PCP 协议交换。

先决条件

- 已安装 PCP。如需更多信息,请参阅安装并启用 PCP。

私有客户端密钥存储在

~/.pcp/tls/client.key文件中。如果您使用其他路径,请调整该流程的对应步骤。有关创建私钥和证书签名请求(CSR)的详细信息,以及如何从证书颁发机构(CA)请求证书,请参阅您的 CA 文档。

-

TLS 客户端证书存储在

~/.pcp/tls/client.crt文件中。如果您使用其他路径,请调整该流程的对应步骤。 -

CA 证书存储在

/etc/pcp/tls/ca.crt文件中。如果您使用其他路径,请调整该流程的对应步骤。

步骤

使用以下信息创建一个 TLS 配置文件:

$ home=

echo ~$ cat > ~/.pcp/tls.conf << END tls-ca-cert-file = /etc/pcp/tls/ca.crt tls-key-file = $home/.pcp/tls/client.key tls-cert-file = $home/.pcp/tls/client.crt END建立安全连接:

$ export PCP_SECURE_SOCKETS=enforce $ export PCP_TLSCONF_PATH=~/.pcp/tls.conf

验证

验证安全连接是否已配置:

$ pminfo --fetch --host pcps://localhost kernel.all.load kernel.all.load inst [1 or "1 minute"] value 1.26 inst [5 or "5 minute"] value 1.29 inst [15 or "15 minute"] value 1.28

5.12. 对高内存使用量进行故障排除

以下情况可能会导致内存用量:

-

pmproxy进程忙于处理新的 PCP 归档,且没有处理 Redis 请求和响应的备用 CPU 周期。 - Redis 节点或集群已过载,且无法在时间处理传入的请求。

pmproxy 服务守护进程使用 Redis 流并支持配置参数,这些参数是 PCP 调优参数,并影响 Redis 内存用量和密钥保留。/etc/pcp/pmproxy/pmproxy.conf 文件列出了 pmproxy 和关联的 API 的可用选项。

以下流程描述了如何对高内存使用率问题进行故障排除。

先决条件

安装

pcp-pmda-redis软件包:# dnf install pcp-pmda-redis

安装 redis PMDA:

# cd /var/lib/pcp/pmdas/redis && ./Install

步骤

要排除高内存用量的问题,请执行以下命令并观察

inflight列:$ pmrep :pmproxy backlog inflight reqs/s resp/s wait req err resp err changed throttled byte count count/s count/s s/s count/s count/s count/s count/s 14:59:08 0 0 N/A N/A N/A N/A N/A N/A N/A 14:59:09 0 0 2268.9 2268.9 28 0 0 2.0 4.0 14:59:10 0 0 0.0 0.0 0 0 0 0.0 0.0 14:59:11 0 0 0.0 0.0 0 0 0 0.0 0.0此列显示有多少 Redis 请求是 in-flight,这意味着它们被排队或发送,目前还没有收到回复。

数字表示以下条件之一:

-

pmproxy进程忙于处理新的 PCP 归档,且没有处理 Redis 请求和响应的备用 CPU 周期。 - Redis 节点或集群已过载,且无法在时间处理传入的请求。

-

要对高内存使用问题进行故障排除,请减少此场的

pmlogger进程数量,再添加另一个 pmlogger 场。使用联邦 - 多个 pmlogger farm 设置。如果 Redis 节点使用 100% 的 CPU 延长的时间,请将其移到具有更好的性能的主机,或使用集群的 Redis 设置。

要查看

pmproxy.redis.*指标,请使用以下命令:$ pminfo -ftd pmproxy.redis pmproxy.redis.responses.wait [wait time for responses] Data Type: 64-bit unsigned int InDom: PM_INDOM_NULL 0xffffffff Semantics: counter Units: microsec value 546028367374 pmproxy.redis.responses.error [number of error responses] Data Type: 64-bit unsigned int InDom: PM_INDOM_NULL 0xffffffff Semantics: counter Units: count value 1164 [...] pmproxy.redis.requests.inflight.bytes [bytes allocated for inflight requests] Data Type: 64-bit int InDom: PM_INDOM_NULL 0xffffffff Semantics: discrete Units: byte value 0 pmproxy.redis.requests.inflight.total [inflight requests] Data Type: 64-bit unsigned int InDom: PM_INDOM_NULL 0xffffffff Semantics: discrete Units: count value 0 [...]要查看有多少 Redis 请求在flight 中,请参阅

pmproxy.redis.requests.inflight.total指标和pmproxy.redis.requests.inflight.bytes指标来查看所有当前在flight Redis 请求中消耗的字节数。通常,redis 请求队列为零,但可以根据大型 pmlogger 场的使用而构建,这限制了可扩展性,并可能导致

pmproxy客户端的高延迟。使用

pminfo命令查看有关性能指标的信息。例如,要查看redis.*指标,请使用以下命令:$ pminfo -ftd redis redis.redis_build_id [Build ID] Data Type: string InDom: 24.0 0x6000000 Semantics: discrete Units: count inst [0 or "localhost:6379"] value "87e335e57cffa755" redis.total_commands_processed [Total number of commands processed by the server] Data Type: 64-bit unsigned int InDom: 24.0 0x6000000 Semantics: counter Units: count inst [0 or "localhost:6379"] value 595627069 [...] redis.used_memory_peak [Peak memory consumed by Redis (in bytes)] Data Type: 32-bit unsigned int InDom: 24.0 0x6000000 Semantics: instant Units: count inst [0 or "localhost:6379"] value 572234920 [...]要查看峰值内存用量,请参阅

redis.used_memory_peak指标。

其他资源

-

pmdaredis (1) 、pmproxy (1)和pminfo (1)man page - PCP 部署架构

第 6 章 使用 pmlogger 记录性能数据

使用 PCP 工具,您可以记录性能指标值并稍后重新显示。这可让您执行改进的性能分析。

使用 pmlogger 工具,您可以:

- 在系统上创建所选指标的归档日志

- 指定系统中记录哪些指标以及它们的频率

6.1. 使用 pmlogconf 修改 pmlogger 配置文件

当 pmlogger 服务运行时,PCP 会记录主机上一组默认指标。

使用 pmlogconf 实用程序检查默认配置。如果 pmlogger 配置文件不存在,则 pmlogconf 会使用默认指标值创建该文件。

先决条件

- 已安装 PCP。如需更多信息,请参阅安装并启用 PCP。

步骤

创建或修改

pmlogger配置文件:# pmlogconf -r /var/lib/pcp/config/pmlogger/config.default

-

按照

pmlogconf提示启用或禁用相关性能指标组,并控制每个启用的组的日志间隔。

其他资源

-

pmlogconf (1)和pmlogger (1)man page - PCP 分发的系统服务和工具

6.2. 手动编辑 pmlogger 配置文件

要使用特定指标和给定间隔创建定制的日志配置,请手动编辑 pmlogger 配置文件。默认 pmlogger 配置文件为 /var/lib/pcp/config/pmlogger/config.default。配置文件指定主日志记录实例记录哪些指标。

在手动配置中,您可以:

- 记录没有列在自动配置中的指标。

- 选择自定义日志记录频率。

- 使用应用程序指标添加 PMDA。

先决条件

- 已安装 PCP。如需更多信息,请参阅安装并启用 PCP。

步骤

打开并编辑

/var/lib/pcp/config/pmlogger/config.default文件以添加特定的指标:# It is safe to make additions from here on ... # log mandatory on every 5 seconds { xfs.write xfs.write_bytes xfs.read xfs.read_bytes } log mandatory on every 10 seconds { xfs.allocs xfs.block_map xfs.transactions xfs.log } [access] disallow * : all; allow localhost : enquire;

其他资源

-

pmlogger (1)man page - PCP 分发的系统服务和工具

6.3. 启用 pmlogger 服务

必须启动并启用 pmlogger 服务,以记录本地计算机上的指标值。

这个步骤描述了如何启用 pmlogger 服务。

先决条件

- 已安装 PCP。如需更多信息,请参阅安装并启用 PCP。

步骤

启动并启用

pmlogger服务:# systemctl start pmlogger # systemctl enable pmlogger

验证步骤

验证

pmlogger服务是否已启用:# pcp Performance Co-Pilot configuration on workstation: platform: Linux workstation 4.18.0-80.el8.x86_64 #1 SMP Wed Mar 13 12:02:46 UTC 2019 x86_64 hardware: 12 cpus, 2 disks, 1 node, 36023MB RAM timezone: CEST-2 services: pmcd pmcd: Version 4.3.0-1, 8 agents, 1 client pmda: root pmcd proc xfs linux mmv kvm jbd2 pmlogger: primary logger: /var/log/pcp/pmlogger/workstation/20190827.15.54

其他资源

-

pmlogger (1)man page - PCP 分发的系统服务和工具

-

/var/lib/pcp/config/pmlogger/config.defaultfile

6.4. 为指标集合设置客户端系统

这个步骤描述了如何设置客户端系统,以便中央服务器能够从运行 PCP 的客户端收集指标。

先决条件

- 已安装 PCP。如需更多信息,请参阅安装并启用 PCP。

步骤

安装

pcp-system-tools软件包:# dnf install pcp-system-tools

为

pmcd配置 IP 地址:# echo "-i 192.168.4.62" >>/etc/pcp/pmcd/pmcd.options使用客户端应侦听的 IP 地址替换 192.168.4.62。

默认情况下,

pmcd侦听 localhost。配置防火墙以永久添加公共

zone:# firewall-cmd --permanent --zone=public --add-port=44321/tcp success # firewall-cmd --reload success

设置 SELinux 布尔值:

# setsebool -P pcp_bind_all_unreserved_ports on

启用

pmcd和pmlogger服务:# systemctl enable pmcd pmlogger # systemctl restart pmcd pmlogger

验证步骤

验证

pmcd是否已正确侦听配置的 IP 地址:# ss -tlp | grep 44321 LISTEN 0 5 127.0.0.1:44321 0.0.0.0:* users:(("pmcd",pid=151595,fd=6)) LISTEN 0 5 192.168.4.62:44321 0.0.0.0:* users:(("pmcd",pid=151595,fd=0)) LISTEN 0 5 [::1]:44321 [::]:* users:(("pmcd",pid=151595,fd=7))

其他资源

-

pmlogger (1),firewall-cmd (1),ss (8), 和setsebool (8)man pages - PCP 分发的系统服务和工具

-

/var/lib/pcp/config/pmlogger/config.defaultfile

6.5. 设置中央服务器以收集数据

这个步骤描述了如何创建中央服务器从运行 PCP 的客户端收集指标。

先决条件

- 已安装 PCP。如需更多信息,请参阅安装并启用 PCP。

- 为指标集合配置了客户端。如需更多信息,请参阅为指标集合设置客户端系统。

步骤

安装

pcp-system-tools软件包:# dnf install pcp-system-tools

使用以下内容创建

/etc/pcp/pmlogger/control.d/remote文件:# DO NOT REMOVE OR EDIT THE FOLLOWING LINE $version=1.1 192.168.4.13 n n PCP_ARCHIVE_DIR/rhel7u4a -r -T24h10m -c config.rhel7u4a 192.168.4.14 n n PCP_ARCHIVE_DIR/rhel6u10a -r -T24h10m -c config.rhel6u10a 192.168.4.62 n n PCP_ARCHIVE_DIR/rhel8u1a -r -T24h10m -c config.rhel8u1a 192.168.4.69 n n PCP_ARCHIVE_DIR/rhel9u3a -r -T24h10m -c config.rhel9u3a

使用客户端 IP 地址替换 192.168.4.13、192.168.4.14、192.168.4.62 和 192.168.4.69。

启用

pmcd和pmlogger服务:# systemctl enable pmcd pmlogger # systemctl restart pmcd pmlogger

验证步骤

确保您可以从每个目录中访问最新的归档文件:

# for i in /var/log/pcp/pmlogger/rhel*/*.0; do pmdumplog -L $i; done Log Label (Log Format Version 2) Performance metrics from host rhel6u10a.local commencing Mon Nov 25 21:55:04.851 2019 ending Mon Nov 25 22:06:04.874 2019 Archive timezone: JST-9 PID for pmlogger: 24002 Log Label (Log Format Version 2) Performance metrics from host rhel7u4a commencing Tue Nov 26 06:49:24.954 2019 ending Tue Nov 26 07:06:24.979 2019 Archive timezone: CET-1 PID for pmlogger: 10941 [..]

/var/log/pcp/pmlogger/目录中的存档文件可用于进一步分析和显示。

其他资源

-

pmlogger (1)man page - PCP 分发的系统服务和工具

-

/var/lib/pcp/config/pmlogger/config.defaultfile

6.6. 使用 pmrep 重现 PCP 日志存档

记录指标数据后,您可以重新执行 PCP 日志存档。要将日志导出到文本文件并将其导入到电子表格中,请使用 pcp2csv、pcp2xml、pmrep 或 pmlogsummary 等。

使用 pmrep 工具,您可以:

- 查看日志文件

- 解析所选 PCP 日志存档,并将值导出到 ASCII 表中

- 通过在命令行中指定单个指标,从日志中提取整个存档日志或只从日志中选择指标值

先决条件

- 已安装 PCP。如需更多信息,请参阅安装并启用 PCP。

-

pmlogger服务已启用。如需更多信息,请参阅启用 pmlogger 服务。 安装

pcp-system-tools软件包:# dnf install pcp-gui

步骤

显示指标上的数据:

$ pmrep --start @3:00am --archive 20211128 --interval 5seconds --samples 10 --output csv disk.dev.write Time,"disk.dev.write-sda","disk.dev.write-sdb" 2021-11-28 03:00:00,, 2021-11-28 03:00:05,4.000,5.200 2021-11-28 03:00:10,1.600,7.600 2021-11-28 03:00:15,0.800,7.100 2021-11-28 03:00:20,16.600,8.400 2021-11-28 03:00:25,21.400,7.200 2021-11-28 03:00:30,21.200,6.800 2021-11-28 03:00:35,21.000,27.600 2021-11-28 03:00:40,12.400,33.800 2021-11-28 03:00:45,9.800,20.600

上述示例以逗号分隔值格式显示存档中以 5 秒 间隔收集的

disk.dev.write指标中的数据。注意将此示例中的

20211128替换为包含您要显示数据的pmlogger存档的文件名。

其他资源

-

pmlogger (1) 、pmrep (1)和pmlogsummary (1)man page - PCP 分发的系统服务和工具

6.7. 启用 PCP 版本 3 归档

Performance Co-Pilot (PCP)归档存储单个主机记录的 PCP 指标的历史值,并支持回顾性性能分析。PCP 归档包含线下或站下分析所需的所有重要指标数据和元数据。这些存档可被大多数 PCP 客户端工具读取,或者由 pmdumplog 工具原始转储。

从 PCP 6.0 开始,除了版本 2 归档外,版本 3 归档也被支持。版本 2 存档保留默认值,除了得到 RHEL 9.2 及之后版本的长期支持的版本 3 之外,出于向后兼容目的,还会继续得到长期支持。

与版本 2 相比,使用 PCP 版本 3 归档提供了以下好处:

- 支持实例域更改增量

- Y2038-safe 时间戳

- 纳秒精度时间戳

- 任意时区支持

- 用于大于 2GB 的单个卷的 64 位文件偏移

前提条件

- 已安装 PCP。如需更多信息,请参阅安装并启用 PCP。

流程

在您选择的文本编辑器中打开

/etc/pcp.conf文件,并设置 PCP 归档版本:PCP_ARCHIVE_VERSION=3

重启

pmlogger服务以应用您的配置更改:# systemctl restart pmlogger.service

- 使用您的新配置创建一个新的 PCP 存档日志。如需更多信息,请参阅使用 pmlogger 的日志记录性能数据。

验证

验证使用新配置创建的归档的版本:

# pmloglabel -l /var/log/pcp/pmlogger/20230208 Log Label (Log Format Version 3) Performance metrics from host host1 commencing Wed Feb 08 00:11:09.396 2023 ending Thu Feb 07 00:13:54.347 2023

其他资源

-

logarchive(5)手册页 -

pmlogger (1)man page - 使用 pmlogger 记录性能数据

第 7 章 使用 Performance Co-Pilot 监控性能

Performance Co-Pilot (PCP) 是用于监控、视觉化、存储和分析系统级性能测量的工具、服务和库集。

作为系统管理员,您可以使用 Red Hat Enterprise Linux 9 中的 PCP 应用程序监控系统性能。

7.1. 使用 pmda-postfix 监控 postfix

这个步骤描述了如何使用 pmda- postfix 监控 postfix 邮件服务器的性能指标。它有助于检查每秒接收多少电子邮件。

先决条件

- 已安装 PCP。如需更多信息,请参阅安装并启用 PCP。

-

pmlogger服务已启用。如需更多信息,请参阅启用 pmlogger 服务。

步骤

安装以下软件包:

安装

pcp-system-tools:# dnf install pcp-system-tools

安装

pmda-postfix软件包以监控postfix:# dnf install pcp-pmda-postfix postfix

安装日志记录守护进程:

# dnf install rsyslog

安装邮件客户端进行测试:

# dnf install mutt

启用

postfix和rsyslog服务:# systemctl enable postfix rsyslog # systemctl restart postfix rsyslog

启用 SELinux 布尔值,以便

pmda-postfix可以访问所需的日志文件:# setsebool -P pcp_read_generic_logs=on

安装

PMDA:# cd /var/lib/pcp/pmdas/postfix/ # ./Install Updating the Performance Metrics Name Space (PMNS) ... Terminate PMDA if already installed ... Updating the PMCD control file, and notifying PMCD ... Waiting for pmcd to terminate ... Starting pmcd ... Check postfix metrics have appeared ... 7 metrics and 58 values

验证步骤

验证

pmda-postfix操作:echo testmail | mutt root

验证可用指标:

# pminfo postfix postfix.received postfix.sent postfix.queues.incoming postfix.queues.maildrop postfix.queues.hold postfix.queues.deferred postfix.queues.active

其他资源

-

rsyslogd (8),postfix (1), 和setsebool (8)man pages - PCP 分发的系统服务和工具

7.2. 使用 PCP Charts 应用程序可视化追踪 PCP 日志存档

记录指标数据后,您可以作为图形重新执行 PCP 日志存档。指标来源于一个或多个实时主机,可通过替代选项将 PCP 日志存档中的指标数据用作历史数据的来源。要自定义 PCP 图表 应用程序接口来显示性能指标中的数据,您可以使用行图表、栏图或利用率图形。

使用 PCP Charts 应用程序,您可以:

- 重播 PCP 图表 应用程序中的数据,并使用图形来视觉化重新内省数据以及系统的实时数据。

- 将性能指标值图表到图表中。

- 同时显示多个 chart。

先决条件

- 已安装 PCP。如需更多信息,请参阅安装并启用 PCP。

-

使用

pmlogger记录性能数据。如需更多信息,请参阅使用 pmlogger 的日志记录性能数据。 安装

pcp-gui软件包:# dnf install pcp-gui

步骤

从命令行启动 PCP Charts 应用程序:

# pmchart

图 7.1. PCP Charts 应用程序

pmtime服务器设置位于底部。可以使用 start 和 pause 按钮控制:- PCP 轮询指标数据的时间间隔

- 历史数据指标的日期和时间

- 点 File 然后点 New Chart,通过指定主机名或地址来选择来自本地机器和远程机器的指标。高级配置选项包括手动设置图表值的功能,以及手动选择图表颜色。

记录在 PCP Charts 应用程序中创建的视图:

以下是获取镜像或记录 PCP Charts 应用程序中创建的视图的选项:

- 点 File,然后点 Export 以保存当前视图的镜像。

- 点 Record,然后 Start 启动记录。点 Record,然后 Stop 停止记录。停止记录后,会存档记录的指标,以便稍后查看。

可选:在 PCP Charts 应用程序中,主配置文件称为 view,允许保存与一个或多个 chart 关联的元数据。此元数据描述了所有图表,包括所使用的指标和图表列。通过点 File 保存自定义 视图 配置,然后保存 View,稍后载入 视图 配置。

以下 PCP 图表 应用程序视图配置文件示例描述了一个堆栈图图,显示了读取和写入到给定 XFS 文件系统

loop1的字节总数:#kmchart version 1 chart title "Filesystem Throughput /loop1" style stacking antialiasing off plot legend "Read rate" metric xfs.read_bytes instance "loop1" plot legend "Write rate" metric xfs.write_bytes instance "loop1"

其他资源

-

pmchart (1)和pmtime (1)man page - PCP 分发的系统服务和工具

7.3. 使用 PCP 从 SQL 服务器收集数据

SQL Server 代理在 Performance Co-Pilot (PCP) 中提供,它可帮助您监控和分析数据库性能问题。

这个步骤描述了如何通过系统中的 pcp 为 Microsoft SQL Server 收集数据。

前提条件

- 您已安装了用于 Red Hat Enterprise Linux 的 Microsoft SQL Server,并建立了与 SQL 服务器的"信任"连接。

- 您已为 Red Hat Enterprise Linux 安装了用于 SQL Server 的 Microsoft ODBC 驱动程序。

流程

安装 PCP:

# dnf install pcp-zeroconf

安装

pyodbc驱动程序所需的软件包:# dnf install python3-pyodbc

安装

mssql代理:为 PCP 安装 Microsoft SQL Server 域名代理:

# dnf install pcp-pmda-mssql

编辑

/etc/pcp/mssql/mssql.conf文件,为mssql代理配置 SQL 服务器帐户的用户名和密码。请确定您配置的帐户具有性能数据的访问权限。username: user_name password: user_password

使用这个帐户的 SQL Server 帐户和 user_password 替换 user_name。

安装代理:

# cd /var/lib/pcp/pmdas/mssql # ./Install Updating the Performance Metrics Name Space (PMNS) ... Terminate PMDA if already installed ... Updating the PMCD control file, and notifying PMCD ... Check mssql metrics have appeared ... 168 metrics and 598 values [...]

验证步骤

使用

pcp命令,验证 SQL Server PMDA (mssql) 是否已加载并在运行:$ pcp Performance Co-Pilot configuration on rhel.local: platform: Linux rhel.local 4.18.0-167.el8.x86_64 #1 SMP Sun Dec 15 01:24:23 UTC 2019 x86_64 hardware: 2 cpus, 1 disk, 1 node, 2770MB RAM timezone: PDT+7 services: pmcd pmproxy pmcd: Version 5.0.2-1, 12 agents, 4 clients pmda: root pmcd proc pmproxy xfs linux nfsclient mmv kvm mssql jbd2 dm pmlogger: primary logger: /var/log/pcp/pmlogger/rhel.local/20200326.16.31 pmie: primary engine: /var/log/pcp/pmie/rhel.local/pmie.log查看 PCP 可以从 SQL Server 收集的指标的完整列表:

# pminfo mssql

查看指标列表后,您可以报告事务的速度。例如,要报告每秒总事务数,超过 5 秒时间窗:

# pmval -t 1 -T 5 mssql.databases.transactions

-

使用

pmchart命令查看系统中的这些指标的图形图表。如需更多信息,请参阅使用 PCP Charts 应用程序进行 Visual tracing PCP 日志归档。

其他资源

-

pcp (1),pminfo (1),pmval (1),pmchart (1), andpmdamssql (1)man pages - 带有 RHEL 8.2 Red Hat Developers Blog 的 Microsoft SQL Server 的 Performance Co-Pilot

7.4. 从 sadc 归档生成 PCP 归档

您可以使用 sysstat 软件包提供的 sadf 工具来生成来自原生 sadc 归档的 PCP 存档。

先决条件

已创建了

sadc存档:# /usr/lib64/sa/sadc 1 5 -

在本例中,

sadc是抽样系统数据 1 时间,间隔为 5 秒。outfile 指定为-,它导致sadc将数据写入标准系统活动每日数据文件。此文件名为 saDD,默认情况下位于 /var/log/sa 目录中。

步骤

从

sadc归档生成 PCP 存档:# sadf -l -O pcparchive=/tmp/recording -2

在本例中,使用

-2选项会导致sadf从sadc归档(2 天)中生成 PCP 存档。

验证步骤

您可以使用 PCP 命令检查和分析 sadc 存档生成的 PCP 存档,正如一个原生 PCP 存档一样。例如:

要显示 PCP 存档中从

sadc归档生成的指标列表,请运行:$ pminfo --archive /tmp/recording Disk.dev.avactive Disk.dev.read Disk.dev.write Disk.dev.blkread [...]

要显示 PCP 归档的归档和主机名的时间范围,请运行:

$ pmdumplog --label /tmp/recording Log Label (Log Format Version 2) Performance metrics from host shard commencing Tue Jul 20 00:10:30.642477 2021 ending Wed Jul 21 00:10:30.222176 2021要将性能指标值绘制成图形,请运行:

$ pmchart --archive /tmp/recording

第 8 章 使用 PCP 对 XFS 的性能分析

XFS PMDA 作为 pcp 软件包的一部分提供,并在安装过程中默认启用。它用于在 Performance Co-Pilot (PCP) 中收集 XFS 文件系统的性能指标数据。

您可以使用 PCP 分析 XFS 文件系统的性能。

8.1. 手动安装 XFS PMDA

如果 pcp 配置输出中没有列出 XFS PMDA,请手动安装 PMDA 代理。

这个步骤描述了如何手动安装 PMDA 代理。

先决条件

- 已安装 PCP。如需更多信息,请参阅安装并启用 PCP。

步骤

进入 xfs 目录:

# cd /var/lib/pcp/pmdas/xfs/

手动安装 XFS PMDA:

xfs]# ./Install Updating the Performance Metrics Name Space (PMNS) ... Terminate PMDA if already installed ... Updating the PMCD control file, and notifying PMCD ... Check xfs metrics have appeared ... 387 metrics and 387 values

验证步骤

验证

pmcd进程是否在主机上运行,且在配置中列出 XFS PMDA:# pcp Performance Co-Pilot configuration on workstation: platform: Linux workstation 4.18.0-80.el8.x86_64 #1 SMP Wed Mar 13 12:02:46 UTC 2019 x86_64 hardware: 12 cpus, 2 disks, 1 node, 36023MB RAM timezone: CEST-2 services: pmcd pmcd: Version 4.3.0-1, 8 agents pmda: root pmcd proc xfs linux mmv kvm jbd2

其他资源

-

pmcd (1)man page - PCP 分发的系统服务和工具

8.2. 使用 pminfo 检查 XFS 性能指标

PCP 启用 XFS PMDA 以允许每个挂载的 XFS 文件系统报告特定的 XFS 指标。这样可以更加轻松地查明特定挂载的文件系统问题并评估性能。

pminfo 命令为每个挂载的 XFS 文件系统提供每个设备 XFS 指标。

此流程显示 XFS PMDA 提供所有可用指标的列表。

先决条件

- 已安装 PCP。如需更多信息,请参阅安装并启用 PCP。

步骤

显示 XFS PMDA 提供的所有可用指标列表:

# pminfo xfs

显示各个指标的信息。以下示例使用

pminfo工具检查特定的 XFS读和写指标:显示

xfs.write_bytes指标的简短描述:# pminfo --oneline xfs.write_bytes xfs.write_bytes [number of bytes written in XFS file system write operations]

显示

xfs.read_bytes指标的长描述:# pminfo --helptext xfs.read_bytes xfs.read_bytes Help: This is the number of bytes read via read(2) system calls to files in XFS file systems. It can be used in conjunction with the read_calls count to calculate the average size of the read operations to file in XFS file systems.

获取

xfs.read_bytes指标的当前性能值:# pminfo --fetch xfs.read_bytes xfs.read_bytes value 4891346238使用

pminfo获取每个设备 XFS 指标:# pminfo --fetch --oneline xfs.perdev.read xfs.perdev.write xfs.perdev.read [number of XFS file system read operations] inst [0 or "loop1"] value 0 inst [0 or "loop2"] value 0 xfs.perdev.write [number of XFS file system write operations] inst [0 or "loop1"] value 86 inst [0 or "loop2"] value 0

其他资源

-

pminfo (1)man page - XFS 的 PCP 指标组

- 每个设备 PCP 指标组用于 XFS

8.3. 使用 pmstore 重置 XFS 性能指标

使用 PCP,您可以修改特定指标的值,特别是当指标充当控制变量时,如 xfs.control.reset 指标。要修改指标值,请使用 pmstore 工具。

这个步骤描述了如何使用 pmstore 工具重置 XFS 指标。