Red Hat Training

A Red Hat training course is available for Red Hat Enterprise Linux

存储管理指南

在 RHEL 7 中部署和配置单节点存储

Milan Navrátil

Jacquelynn East

Don Domingo

摘要

第 1 章 概述

1.1. Red Hat Enterprise Linux 7 中的新功能和增强功能

不包括 eCryptfs

系统存储管理器

XFS 是默认文件系统

文件系统重组

/bin、/sbin、/lib 和 /lib64 现在嵌套在 /usr 下。

snapper

Btrfs(技术预览)

NFSv2 没有支持长

部分 I. 文件系统

第 2 章 文件系统结构和维护

- 可共享和不可取的文件

- 可以在本地和远程主机访问 可共享 文件。Unsharable 文件仅在本地可用。

- 变量和静态文件

- 变量文件 (如文档)可以随时更改。静态文件 (如二进制文件)不会在没有系统管理员的操作的情况下改变。

2.1. 文件系统层次结构标准(FHS)概述.

- 与其他符合 FHS 的系统兼容

- 能够以只读形式挂载

/usr/分区。这很重要,因为/usr/包含常见的可执行文件,用户不应更改。此外,由于/usr/以只读形式挂载,它应该可以从 CD-ROM 驱动器或通过只读 NFS 挂载从另一台机器挂载。

2.1.1. FHS 组织

2.1.1.1. 收集文件系统信息

df 命令

例 2.1. df 命令输出

Filesystem 1K-blocks Used Available Use% Mounted on

/dev/mapper/VolGroup00-LogVol00

11675568 6272120 4810348 57% / /dev/sda1

100691 9281 86211 10% /boot

none 322856 0 322856 0% /dev/shm

例 2.2. df -h 命令输出

Filesystem Size Used Avail Use% Mounted on

/dev/mapper/VolGroup00-LogVol00

12G 6.0G 4.6G 57% / /dev/sda1

99M 9.1M 85M 10% /boot

none 316M 0 316M 0% /dev/shm

/dev/shm 代表系统的虚拟内存文件系统。

DU 命令

GNOME 系统监控器

图 2.1. GNOME 系统监控器中的文件系统选项卡

[D]

2.1.1.2. /boot/ 目录

/boot/ 目录包含引导系统所需的静态文件,例如 Linux 内核。这些文件对于系统正常启动至关重要。

/boot/ 目录。这样做会使系统无法启动。

2.1.1.3. /dev/ 目录

/dev/ 目录包含代表以下设备类型的设备节点:

- 连接到系统的设备;

- 内核提供的虚拟设备.

/dev/ 中创建和删除设备节点。

/dev/ 目录和子目录中的设备定义为 字符 (仅提供输入和输出的串行流,如鼠标或键盘)或 块 (随机访问,如硬盘驱动器或软盘驱动器)。如果安装了 GNOME 或 KDE,则连接(如使用 USB)或插入(如 CD 或者 DVD 驱动器)时会自动检测一些存储设备,并显示其内容的弹出窗口。

表 2.1. /dev 目录中通用文件的示例

| File | 描述 |

|---|---|

/dev/hda | 主 IDE 通道上的主设备。 |

/dev/hdb | 主 IDE 通道上的从设备. |

/dev/tty0 | 第一个虚拟控制台. |

/dev/tty1 | 第二个虚拟控制台. |

/dev/sda | 主 SCSI 或 SATA 通道中的第一个设备。 |

/dev/lp0 | 第一个并行端口。 |

- 映射设备

- 卷组中的逻辑卷,例如

/dev/mapper/VolGroup00-LogVol02。 - 静态设备

- 传统存储卷,例如 /dev/sdbX,其中 sdb 是存储设备名称,X 是分区号。

/dev/sdbX也可以是/dev/disk/by-id/WWID,或/dev/disk/by-uuid/UUID。如需更多信息,请参阅 第 25.8 节 “持久性命名”。

2.1.1.4. /etc/ 目录

/etc/ 目录保留机器本地的配置文件。它不应包含任何二进制文件;如果存在二进制文件,请将其移到 /usr/bin/ 或 /usr/sbin/。

/etc/skel/ 目录存储"框架"用户文件,这些文件用于在首次创建用户时填充主目录。应用也将其配置文件存储在此目录中,并且在执行时可能会引用这些文件。/etc/exports 文件控制哪些文件系统导出到远程主机。

2.1.1.5. /mnt/ 目录

/mnt/ 目录,如 NFS 文件系统挂载。对于所有可移动存储介质,请使用 /media/ 目录。自动检测到的可移动介质挂载在 /media 目录中。

/mnt 目录。

2.1.1.6. /opt/ 目录

/opt/ 目录通常为不属于默认安装的软件和附加软件包保留。安装到 /opt/ 的软件包会创建一个目录,例如,/opt/packagename/。在大多数情况下,此类软件包遵循可预测的子目录结构;大多数软件包将其二进制文件存储在 /opt/packagename/bin/ 中,其 man page 存储在 /opt/packagename/man/ 中。

2.1.1.7. /proc/ 目录

2.1.1.8. /srv/ 目录

/srv/ 目录包含 Red Hat Enterprise Linux 系统提供的特定于站点的数据。此目录为用户提供特定服务(如 FTP、WWW 或 CVS)的数据文件的位置。仅与特定用户相关的数据应位于 /home/ 目录中。

2.1.1.9. /sys/ 目录

/sys/ 目录利用特定于内核的新 sysfs 虚拟文件系统。随着对内核中热插硬件设备的支持,/sys/ 目录包含与 /proc/ 持有的信息相似,但显示特定于热插拔设备的设备信息的层次结构视图。

2.1.1.10. /usr/ 目录

/usr/ 目录用于可在多台机器之间共享的文件。/usr/ 目录通常位于其自己的分区上,并以只读形式挂载。至少,/usr/ 应该包含以下子目录:

/usr/bin- 此目录用于二进制文件。

/usr/etc- 此目录用于系统范围的配置文件。

/usr/games- 此目录存储游戏。

/usr/include- 此目录用于 C 头文件。

/usr/kerberos- 此目录用于与 Kerberos 相关的二进制文件和文件。

/usr/lib- 此目录用于设计不是由 shell 脚本或用户直接使用的对象文件和库。从 Red Hat Enterprise Linux 7.0 开始,

/lib/目录已与/usr/lib合并。现在,它还包含在/usr/bin/和 /usr/sbin/ 中执行二进制文件所需的库。这些共享库镜像用于引导系统或执行根文件系统中的命令。 /usr/libexec- 此目录包含其他程序调用的小型帮助程序。

/usr/sbin- 从 Red Hat Enterprise Linux 7.0 开始,

/sbin已移到/usr/sbin中。这意味着它包含所有系统管理二进制文件,包括启动、恢复、恢复或修复系统所必需的。/usr/sbin/中的二进制文件需要 root 特权才能使用。 /usr/share- 此目录存储不特定于架构的文件。

/usr/src- 此目录存储源代码。

/usr/tmp链接到/var/tmp- 此目录存储临时文件。

/usr/ 目录还应包含 /local/ 子目录。根据 FHS,系统管理员在本地安装软件时会使用这个子目录,在系统更新时应该不会被覆盖。/usr/local 目录的结构与 /usr/ 类似,包含以下子目录:

/usr/local/bin/usr/local/etc/usr/local/games/usr/local/include/usr/local/lib/usr/local/libexec/usr/local/sbin/usr/local/share/usr/local/src

/usr/local/ 的使用与 FHS 稍有不同。FHS 指出 /usr/local/ 应该用于存储系统软件升级安全的软件。由于 RPM Package Manager 可以安全地执行软件升级,因此不需要通过将文件存储在 /usr/local/ 中来保护文件。

/usr/local/ 用于机器本地的软件。例如,如果 /usr/ 目录作为只读 NFS 共享从远程主机挂载,那么仍然可以将软件包或程序安装到 /usr/local/ 目录下。

2.1.1.11. /var/ 目录

/usr/ 挂载为只读,因此任何写入日志文件或需要 spool/ 或 lock/ 目录的程序都应将它们写入 /var/ 目录。FHS 指出 /var/ 用于变量数据,其中包括 spool 目录和文件、日志记录数据、临时和临时文件。

/var/ 目录中找到的一些目录:

/var/account//var/arpwatch//var/cache//var/crash//var/db//var/empty//var/ftp//var/gdm//var/kerberos//var/lib//var/local//var/lock//var/log/- 链接到

/var/spool/mail/的/var/mail /var/mailman//var/named//var/nis//var/opt//var/preserve//var/run//var/spool//var/tmp//var/tux//var/www//var/yp/

/var/run/media/user 目录包含用作可移动介质挂载点的子目录,如 USB 存储介质、DVD、CD-ROM 和 Zip 磁盘。请注意,/media/ 目录用于此目的。

messages 和 lastlog )位于 /var/log/ 目录中。/var/lib/rpm/ 目录包含 RPM 系统数据库。锁定文件位于 /var/lock/ 目录中,通常位于使用该文件的程序的目录中。/var/spool/ 目录有存储某些程序数据文件的子目录。这些子目录包括:

/var/spool/at//var/spool/clientmqueue//var/spool/cron//var/spool/cups//var/spool/exim//var/spool/lpd//var/spool/mail//var/spool/mailman//var/spool/mqueue//var/spool/news//var/spool/postfix//var/spool/repackage//var/spool/rwho//var/spool/samba//var/spool/squid//var/spool/squirrelmail//var/spool/up2date//var/spool/uucp//var/spool/uucppublic//var/spool/vbox/

2.2. 特殊 Red Hat Enterprise Linux 文件位置

/var/lib/rpm/ 目录中。有关 RPM 的更多信息,请参阅 man rpm。

/var/cache/yum/ 目录包含 Package Updater 使用的文件,包括系统的 RPM 标头信息。此位置还可用于在更新系统时临时存储下载的 RPM。有关红帽网络的详情请参考 https://rhn.redhat.com/。

/etc/sysconfig/ 目录。该目录存储各种配置信息。许多在启动时运行的脚本都使用此目录中的文件。

2.3. /proc 虚拟文件系统

/proc 既不包含文本文件,也不包含二进制文件。由于它托管了 虚拟文件,/proc 被称为虚拟文件系统。这些虚拟文件的大小通常为零字节,即使它们包含大量信息。

/proc 文件系统不用于存储。它的主要用途是为硬件、内存、运行进程和其他系统组件提供基于文件的接口。可以通过查看相应的 /proc 文件,在多个系统组件上检索实时信息。还可以操作 /proc 中的某些文件(用户和应用程序)来配置内核。

/proc 文件与管理和监控系统存储相关:

- /proc/devices

- 显示当前配置的各种字符和块设备。

- /proc/filesystems

- 列出内核当前支持的所有文件系统类型。

- /proc/mdstat

- 包含系统上多个磁盘或 RAID 配置(如果存在)的当前信息。

- /proc/mounts

- 列出系统当前使用的所有挂载。

- /proc/partitions

- 包含分区块分配信息.

/proc 文件系统的更多信息,请参阅 Red Hat Enterprise Linux 7 部署指南。

2.4. 丢弃未使用的块

- 批量丢弃操作 由用户使用 fstrim 命令显式运行。此命令丢弃文件系统中符合用户条件的所有未使用的块。

- 在线丢弃操作 在挂载时指定,可以使用

-o discard选项作为 mount 命令的一部分,也可以使用/etc/fstab文件中的discard选项。它们在没有用户干预的情况下实时运行。在线丢弃操作只丢弃从已使用转变为空闲的块。

/sys/block/设备/queue/discard_max_bytes 文件中存储的值不为零,则支持物理丢弃操作。

- 不支持丢弃操作的设备,或者

- 一个由多个设备组成的逻辑设备(LVM 或者 MD),其中任何一个设备都不支持丢弃操作

fstrim -v /mnt/non_discard

fstrim: /mnt/non_discard: the discard operation is not supported

第 3 章 XFS 文件系统

- XFS 的主要功能

- XFS 支持 元数据日志 ,这有助于更快地恢复崩溃。

- XFS 文件系统可以在挂载和激活时进行碎片整理和放大。

- 另外,Red Hat Enterprise Linux 7 支持特定于 XFS 的备份和恢复工具。

- 分配功能

- XFS 具有以下分配方案:

- 基于数据块的分配

- 条带化分配策略

- 延迟分配

- 空间预分配

延迟分配和其他性能优化对 XFS 的影响与对 ext4 的影响一样。即,程序对 XFS 文件系统的写操作无法保证为磁盘上,除非程序随后发出 fsync () 调用。有关延迟分配对文件系统(ext4 和 XFS)的影响的更多信息,请参阅 分配功能 中的 第 5 章 ext4 文件系统。注意创建或扩展文件偶尔会失败,并显示意外的 ENOSPC 写入失败,即使磁盘空间似乎足够了。这是因为 XFS 的性能导向型设计。实际上,它不会成为问题,因为它只有在剩余空间只是几个块时才会发生。 - 其他 XFS 功能

- XFS 文件系统还支持以下内容:

- 扩展的属性 (

xattr) - 这允许系统能够按文件关联多个额外的名称/值对。它会被默认启用。

- 配额日志

- 这可避免在崩溃后需要进行冗长的配额一致性检查。

- 项目/目录配额

- 这允许对目录树的配额限制。

- 小于秒的时间戳

- 这允许时间戳进入亚秒。

- 扩展的属性 (

- 默认 atime 行为是 relatime

- 对于 XFS,relatime 默认为 on。与 noatime 相比,它几乎没有开销,同时仍维护 sane atime 值。

3.1. 创建 XFS 文件系统

- 要创建 XFS 文件系统,请使用以下命令:

#mkfs.xfs block_device- 使用到块设备的路径替换 block_device。例如:

/dev/sdb1,/dev/disk/by-uuid/05e99ec8-def1-4a5e-8a9d-5945339ceb2a, 或/dev/my-volgroup/my-lv。 - 一般情况下,默认选项是常见用途的最佳选择。

- 在包含现有文件系统的块设备上使用 mkfs.xfs 时,添加

-f选项来覆盖该文件系统。

例 3.1. mkfs.xfs 命令输出

meta-data=/dev/device isize=256 agcount=4, agsize=3277258 blks

= sectsz=512 attr=2

data = bsize=4096 blocks=13109032, imaxpct=25

= sunit=0 swidth=0 blks

naming =version 2 bsize=4096 ascii-ci=0

log =internal log bsize=4096 blocks=6400, version=2

= sectsz=512 sunit=0 blks, lazy-count=1

realtime =none extsz=4096 blocks=0, rtextents=0

条带块设备

mkfs 工具(用于 ext3、ext4 和 xfs)将自动使用此 geometry。如果 mkfs 工具没有检测到条带几何结构,即使存储确实有条带几何结构,则可以在使用以下选项创建文件系统时手动指定它:

- su=value

- 指定条带单位或 RAID 块大小。该值必须 以字节为单位,使用可选的

k、m或g后缀。 - sw=value

- 指定 RAID 设备中数据磁盘的数量,或者条带中条带单位的数量。

# mkfs.xfs -d su=64k,sw=4 /dev/block_device其它资源

3.2. 挂载 XFS 文件系统

# mount /dev/device /mount/pointmke2fs 不同,mkfs.xfs 不使用配置文件;它们都是在命令行中指定的。

写屏障

# mount -o nobarrier /dev/device /mount/point直接访问技术预览

直接访问 (DAX)。应用是一种将持久内存直接映射到其地址空间的方法。要使用 DAX,系统必须有某种可用的持久性内存,通常使用一个或多个非易失性双内存模块(NVDIMM),必须在 NVDIMM 上创建支持 DAX 的文件系统。另外,该文件系统必须使用 dax 挂载选项挂载。然后,在 dax 挂载的文件系统中的一个文件 mmap 会导致存储直接映射到应用程序的地址空间中。

3.3. XFS 配额管理

- uquota/uqnoenforce: 用户配额

- gquota/gqnoenforce: 组配额

- pquota/pqnoenforce: 项目配额

- quota username/userID

- 显示给定 username 或数字 userID的使用情况和限制

- df

- 显示块和 inode 的空闲和已使用数。

# xfs_quota -x- report /path

- 报告特定文件系统的配额信息。

- limit

- 修改配额限制。

例 3.2. 显示示例配额报告

/home 的配额报告示例(在 /dev/blockdevice上),请使用命令 xfs_quota -x -c 'report -h' /home。此时会显示类似如下的输出:

User quota on /home (/dev/blockdevice) Blocks User ID Used Soft Hard Warn/Grace ---------- --------------------------------- root 0 0 0 00 [------] testuser 103.4G 0 0 00 [------] ...

john 设置软和硬内节点计数限制为 500 和 700,其主目录为 /home/john,请使用以下命令:

# xfs_quota -x -c 'limit isoft=500 ihard=700 john' /home/例 3.3. 设置 Soft 和 Hard Block Limit

/target/path 文件系统上的 accounting 进行分组,请使用以下命令:

# xfs_quota -x -c 'limit -g bsoft=1000m bhard=1200m accounting' /target/path设置项目限制

- 将项目控制的目录添加到

/etc/projects。例如,以下命令将唯一 ID 为 11 的/var/log路径添加到/etc/projects。您的项目 ID 可以是任何映射到项目的数字值。#echo 11:/var/log >> /etc/projects - 将项目名称添加到

/etc/projid,将项目 ID 映射到项目名称。例如,以下命令将名为 logfiles 的项目与上一步中定义的项目 ID 11 关联:#echo logfiles:11 >> /etc/projid - 初始化项目目录。例如,以下命令初始化项目目录

/var:#xfs_quota -x -c 'project -s logfiles' /var - 为使用初始化目录的项目配置配额:

#xfs_quota -x -c 'limit -p bhard=lg logfiles' /var

3.4. 增加 XFS 文件系统的大小

# xfs_growfs /mount/point -D size3.5. 修复 XFS 文件系统

# xfs_repair /dev/device3.6. 暂停 XFS 文件系统

# xfs_freeze mount-pointxfsprogs 软件包提供,该软件包仅适用于 x86_64。

# xfs_freeze -f /mount/point

# xfs_freeze -u /mount/point3.7. 备份和恢复 XFS 文件系统

- 用于创建备份的 xfsdump

- xfsrestore 用于从备份中恢复

3.7.1. XFS 备份和恢复的功能

Backup

xfsdump 工具来:

- 对常规文件镜像执行备份。只能将一个备份写入常规文件。

- 在磁带驱动器中执行备份。

xfsdump工具还允许您将多个备份写入同一磁带。备份可跨越多个标题。要将多个文件系统备份到单个磁带设备,只需将备份写入已包含 XFS 备份的磁带。这会将新备份附加到上一个备份。默认情况下,xfsdump不会覆盖现有的备份。 - 创建增量备份。

xfsdump工具使用 转储级别 来决定其他备份相对的基本备份。从0到9的数字指的是增加的转储级别。增量备份只备份自上一次较低级别转储以来发生变化的文件:- 要执行全备份,请在 文件系统中执行 0 级 转储。

- 1 级转储是全备份后的第一个增量备份。下一个增量备份为 2 级,它仅备份自上 1 级转储后更改的文件,以此类推,最多为 9 级。

- 使用大小、子树或 inode 标志从备份中排除文件,以过滤它们。

恢复

xfsrestore 交互模式。交互模式提供了一组命令来操作备份文件。

3.7.2. 备份 XFS 文件系统

过程 3.1. 备份 XFS 文件系统

- 使用以下命令备份 XFS 文件系统:

#xfsdump -l level [-L label] -f backup-destination path-to-xfs-filesystem- 使用备份的转储级别替换 level。使用

0执行完整备份,或1到9执行后续增量备份。 - 使用您要存储备份的路径替换 backup-destination。目的地可以是常规文件、磁带驱动器或远程磁带设备。例如:用于文件的

/backup-files/Data.xfsdump,对于磁带驱动器,/dev/st0。 - 使用您要备份的 XFS 文件系统的挂载点替换 path-to-xfs-filesystem。例如:

/mnt/data/。文件系统必须挂载。 - 当备份多个文件系统并将其保存到单个磁带设备中时,使用

-L label选项为每个备份添加一个会话标签,以便在恢复时更容易识别它们。使用备份的任何名称替换 label :例如backup_data。

例 3.4. 备份多个 XFS 文件系统

- 要备份挂载在

/boot/和/data/目录中的 XFS 文件系统的内容,并将其保存为/backup-files/目录中的文件:#xfsdump -l 0 -f /backup-files/boot.xfsdump /boot#xfsdump -l 0 -f /backup-files/data.xfsdump /data - 要备份单个磁带设备中的多个文件系统,请使用

-L label选项为每个备份添加一个会话标签:#xfsdump -l 0 -L "backup_boot" -f /dev/st0 /boot#xfsdump -l 0 -L "backup_data" -f /dev/st0 /data

其它资源

- 有关备份 XFS 文件系统的详情请参考 xfsdump(8) man page。

3.7.3. 从备份中恢复 XFS 文件系统

先决条件

- 您需要 XFS 文件系统的文件或者磁带备份,如 第 3.7.2 节 “备份 XFS 文件系统” 所述。

过程 3.2. 从备份中恢复 XFS 文件系统

- 恢复备份的命令因您是从全备份或增量备份中恢复,还是从单个磁带设备恢复多个备份而有所不同:

#xfsrestore [-r] [-S session-id] [-L session-label] [-i]-f backup-locationrestoration-path- 使用备份位置替换 backup-location。这可以是常规文件、磁带驱动器或远程磁带设备。例如:用于文件的

/backup-files/Data.xfsdump,对于磁带驱动器,/dev/st0。 - 使用您要 恢复文件系统的目录的路径替换 restore- path。例如:

/mnt/data/。 - 要从增量(1 级到 9 级)备份恢复文件系统,请添加

-r选项。 - 要从包含多个备份的磁带设备恢复备份,请使用

-S或-L选项指定备份。-S允许您通过其会话 ID 选择备份,而-L则允许您按会话标签选择。要获取会话 ID 和会话标签,请使用 xfsrestore -I 命令。使用备份的会话 ID 替换 session-id。例如,b74a3586-e52e-4a4a-8775-c3334fa8ea2c。使用备份的会话标签替换 session-label。例如,my_backup_session_label。 - 要以交互方式使用

xfsrestore,请使用-i选项。xfsrestore完成读取指定设备后,交互式对话框开始。交互式xfsrestoreshell 中的可用命令包括 cd,ls,add,delete, 和 extract; 如需命令的完整列表,请使用 help 命令。

例 3.5. 恢复多个 XFS 文件系统

/mnt/ 下的目录中:

#xfsrestore -f /backup-files/boot.xfsdump /mnt/boot/#xfsrestore -f /backup-files/data.xfsdump /mnt/data/

#xfsrestore -f /dev/st0 -L "backup_boot" /mnt/boot/#xfsrestore -f /dev/st0 -S "45e9af35-efd2-4244-87bc-4762e476cbab" /mnt/data/

从 Tape 恢复备份时的信息性消息

xfsrestore 工具可能会发出信息。当 xfsrestore 按顺序检查磁带上的每个备份时,信息会告知您是否找到了与请求的备份相匹配。例如:

xfsrestore: preparing drive xfsrestore: examining media file 0 xfsrestore: inventory session uuid (8590224e-3c93-469c-a311-fc8f23029b2a) does not match the media header's session uuid (7eda9f86-f1e9-4dfd-b1d4-c50467912408) xfsrestore: examining media file 1 xfsrestore: inventory session uuid (8590224e-3c93-469c-a311-fc8f23029b2a) does not match the media header's session uuid (7eda9f86-f1e9-4dfd-b1d4-c50467912408) [...]

其它资源

- 有关恢复 XFS 文件系统的详情请参考 xfsrestore(8) man page。

3.8. 配置错误行为

- 继续重试,直到出现以下任一操作:

- I/O 操作成功,或者

- 超过 I/O 操作重试计数或时间限制。

- 考虑永久错误并停止系统。

EIO: 在尝试写入设备时出现错误ENOSPC: 该设备中没有剩余空间ENODEV: Device cannot found

3.8.1. 特定和未定义的条件的配置文件

/sys/fs/xfs/device/error/ 目录中。

/sys/fs/xfs/设备/error/metadata/ 目录包含每个特定错误条件的子目录:

- 用于

EIO 错误条件的 /sys/fs/xfs/device/error/metadata/EIO/ /sys/fs/xfs/device/error/metadata/ENODEV/用于ENODEV错误条件/sys/fs/xfs/device/error/metadata/ENOSPC/用于ENOSPC错误条件

/sys/fs/xfs/device/error/metadata/condition/max_retries: 控制 XFS 重新尝试操作的最大次数。/sys/fs/xfs/device/error/metadata/condition/retry_timeout_seconds: XFS 将停止重试操作的时间限制(以秒为单位)

/sys/fs/xfs/device/error/metadata/default/max_retries: 控制重试的最大次数/sys/fs/xfs/device/error/metadata/default/retry_timeout_seconds: 控制重试的时间限制

3.8.2. 为特定和未定义条件设置文件系统行为

max_retries 文件。

- 对于特定条件:

#echo value > /sys/fs/xfs/device/error/metadata/condition/max_retries - 对于未定义的条件:

#echo value > /sys/fs/xfs/device/error/metadata/default/max_retries

-1 和最大可能值为 int 的值(C 签名的整数类型)之间的数字。64 位 Linux 中是 2147483647。

retry_timeout_seconds 文件。

- 对于特定条件:

#echo value > /sys/fs/xfs/device/error/metadata/condition/retry_timeout_seconds - 对于未定义的条件:

#echo value > /sys/fs/xfs/device/error/metadata/default/retry_timeout_seconds

-1 和 86400 之间的数字,这是一天的秒数。

max_retries 和 retry_timeout_seconds 选项中,-1 表示重试 forever 和 0 以立即停止。

/dev/ 目录中找到,例如: sda。

ENODEV )被视为致命且不可恢复的,无论重试计数如何,其默认值为 0。

3.8.3. 设置卸载行为

fail_at_unmount 选项,文件系统会在卸载过程中覆盖所有其他错误配置,并在不重试 I/O 操作的情况下立即修改文件系统。这允许卸载操作在出现持久错误时也可以成功。

# echo value > /sys/fs/xfs/device/error/fail_at_unmount1 或 0 :

1表示如果找到错误,则立即取消重试。0表示遵守max_retries和retry_timeout_seconds选项。

/dev/ 目录中找到,例如: sda。

fail_at_unmount 选项。启动卸载操作后,配置文件和目录可能无法使用。

3.9. 其他 XFS 文件系统工具

- xfs_fsr

- 用于对已挂载的 XFS 文件系统进行碎片整理。当不使用任何参数调用时,xfs_fsr 会对所有挂载的 XFS 文件系统中的所有常规文件进行碎片整理。此工具还允许用户在指定的时间暂停碎片整理,并在以后从其停止的地方恢复。另外,xfs_fsr 还允许只对一个文件进行碎片整理,如 xfs_fsr /path/to/file中所述。红帽建议不要定期取消整个文件系统碎片,因为 XFS 默认避免碎片。系统范围的碎片整理可能会导致空闲空间出现碎片的影响。

- xfs_bmap

- 打印 XFS 文件系统中文件所使用的磁盘块图。此图列出了指定文件所使用的每一个块,以及文件中没有相应块(即漏洞)的区域。

- xfs_info

- 打印 XFS 文件系统信息.

- xfs_admin

- 更改 XFS 文件系统的参数.xfs_admin 工具只能修改卸载的设备或文件系统的参数。

- xfs_copy

- 将整个 XFS 文件系统的内容并行复制到一个或多个目的地。

- xfs_metadump

- 将 XFS 文件系统元数据复制到文件中。红帽只支持使用 xfs_metadump 工具复制卸载的文件系统或只读挂载的文件系统;否则,生成的转储可能会损坏或不一致。

- xfs_mdrestore

- 将 XFS metadump 镜像(使用 xfs_metadump生成)恢复到文件系统镜像。

- xfs_db

- 调试 XFS 文件系统。

3.10. 从 ext4 迁移到 XFS

3.10.1. Ext3/4 和 XFS 之间的区别

- 文件系统修复

- Ext3/4 在引导时在用户空间中运行 e2fsck,以便根据需要恢复日志。相比之下,XFS 在挂载时在内核空间中执行日志恢复。提供了

fsck.xfsshell 脚本,但不执行任何有用的操作,因为它只能满足 initscript 要求。当请求 XFS 文件系统修复或检查时,请使用 xfs_repair 命令。使用 -n 选项进行只读检查。xfs_repair 命令不会在带有脏日志的文件系统上运行。要修复此类文件系统 挂载和卸载 ,必须首先执行重新执行来回放日志。如果日志损坏且无法重新执行,可以在日志中使用 -L 选项为零。有关 XFS 文件系统修复文件系统的更多信息,请参阅 第 12.2.2 节 “XFS” - 元数据错误行为

- 当遇到元数据错误时,ext3/4 文件系统具有可配置的行为,其默认设置只是继续。当 XFS 遇到不可恢复的元数据错误时,它将关闭文件系统并返回

EFSCORRUPTED错误。系统日志将包含遇到的错误的详情,并在需要时推荐运行 xfs_repair。 - 配额

- XFS 配额不是一个可重新挂载的选项。必须在初始挂载上指定 -o quota 选项,才能使配额生效。虽然 quota 软件包中的标准工具可以执行基本的配额管理任务(如 setquota 和 repquota), xfs_quota 工具可用于特定于 XFS 的功能,如项目配额管理。quotacheck 命令对 XFS 文件系统没有影响。第一次在 XFS 上打开配额核算时,会在内部执行自动 quotacheck。由于 XFS 配额元数据是第一类,因此日志的元数据对象将始终一致,直到手动关闭配额为止。

- 文件系统重新定义大小

- XFS 文件系统没有工具来缩小文件系统。XFS 文件系统可以通过 xfs_growfs 命令在线增长。

- 内节点(inode)号

- 对于大于 1 TB 且具有 256 字节索引节点的文件系统,或者大于 2 TB,XFS 索引节点编号可能超过 2^32。这种大型索引节点编号会导致 32 位 stat 调用失败,并显示 EOVERFLOW 返回值。使用默认的 Red Hat Enterprise Linux 7 配置时,上面描述的问题可能会发生:使用四个分配组非条带化。自定义配置(如文件系统扩展或更改 XFS 文件系统参数)可能会导致不同的行为。应用程序通常正确处理此类更大的索引节点编号。如果需要,使用 -o inode32 参数挂载 XFS 文件系统,以强制低于 2^32 的 inode 号。请注意,使用

inode32不会影响已分配了 64 位数的 inode。重要除非特定环境需要,否则不要使用inode32选项。inode32选项可改变分配行为。因此,如果没有可用空间在较低磁盘块中分配 inode,则可能会出现 ENOSPC 错误。 - 定性预分配

- XFS 使用 规范预分配 来分配块过去 EOF,因为文件被写入。这可避免因为 NFS 服务器上的并发流写工作负载造成文件碎片。默认情况下,此预分配会增加文件大小,并将在"du"输出中明显显示。如果没有在五分钟内没有指定指定预分配的文件,则会丢弃预分配。如果内节点在这个时间前从缓存中循环,则当内节点被回收时,将丢弃预分配。如果因为定性预分配而看到了预规划 ENOSPC 问题,可以使用 -o allocsize=amount 挂载选项指定固定的预分配量。

- 与碎片相关的工具

- 由于 Heuristics 和行为(如延迟分配和规范预分配)导致 XFS 文件系统来说,碎片很少发生。但是,存在用于衡量文件系统碎片的工具,以及对文件系统进行碎片整理。不鼓励使用它们。xfs_db frag 命令尝试将所有文件系统分配成单个碎片编号,以百分比表示。命令的输出需要大量的专业知识才能理解其含义。例如,一个碎片因数为 75% 意味着每个文件平均有 4 个扩展。因此,xfs_db 的 frag 的输出不被视为有用,并建议更小心地分析任何碎片问题。警告xfs_fsr 命令可用于对单个文件或文件系统上的所有文件进行碎片整理。强烈建议不要这样做,因为它可能会破坏文件的本地性,并可能出现碎片释放的空间。

使用 ext3 和 ext4 的命令与 XFS 的比较

表 3.1. ext3 和 ext4 的通用命令与 XFS 的比较

| 任务 | ext3/4 | XFS |

|---|---|---|

| 创建文件系统 | mkfs.ext4 or mkfs.ext3 | mkfs.xfs |

| 文件系统检查 | e2fsck | xfs_repair |

| 重新定义文件系统大小 | resize2fs | xfs_growfs |

| 保存文件系统的镜像 | e2image | xfs_metadump 和 xfs_mdrestore |

| 标签或者调整文件系统 | tune2fs | xfs_admin |

| 备份文件系统 | dump 和 restore | xfsdump 和 xfsrestore |

表 3.2. ext4 和 XFS 的通用工具

| 任务 | ext4 | XFS |

|---|---|---|

| Quota | quota | xfs_quota |

| 文件映射 | filefrag | xfs_bmap |

第 4 章 ext3 文件系统

- 可用性

- 在意外的电源故障或系统崩溃(也称为 未清理的系统关闭)后,机器上每个挂载的 ext2 文件系统都必须通过 e2fsck 程序检查一致性。这是一个耗时的过程,可能会显著延迟系统引导时间,特别是对于包含大量文件的大量卷而言。在这段时间中,卷上的任何数据都不可访问。可以在实时文件系统上运行 fsck -n。但是,如果遇到写入了部分元数据,它不会进行任何更改,并且可能会产生误导。如果在堆栈中使用 LVM,另一个选项是生成文件系统的 LVM 快照,并在其上运行 fsck。最后,您可以选择以只读形式重新挂载文件系统。然后,在重新挂载前,所有待处理的元数据更新(及写入)都会强制到磁盘中。这样可确保文件系统处于一致状态,前提是之前没有损坏。现在,可以运行 fsck -n。ext3 文件系统提供的日志意味着,在未清理的系统关闭后,不再需要此类文件系统检查。使用 ext3 进行一致性检查的唯一时间是在某些罕见的硬件故障情形中,如硬盘驱动器故障。在未清理的系统关闭后恢复 ext3 文件系统的时间不取决于文件系统的大小或文件的数量,而是取决于用于保持一致性的 日志 的大小。默认日志大小大约需要一秒钟就能恢复,具体取决于硬件的速度。注意红帽支持的 ext3 中的唯一日志模式是 data=ordered (默认)。

- 数据完整性

- ext3 文件系统防止发生未清理系统关闭时数据完整性的丢失。ext3 文件系统允许您选择数据接受的保护类型和级别。对于文件系统的状态,ext3 卷配置为默认保持高级别的数据一致性。

- 速度

- 尽管多次写入一些数据,但大多数情况下, ext3 的吞吐量高于 ext2,因为 ext3 的日志优化了硬盘驱动器磁头的移动。您可以从三种日志记录模式中进行选择来优化速度,但这样做意味着在系统出现故障时要权衡数据的完整性。注意红帽支持的 ext3 中的唯一日志模式是 data=ordered (默认)。

- 轻松迁移

- 可轻松从 ext2 迁移到 ext3,并获得强大的日志记录文件系统的优势,而无需重新格式化。有关执行此任务的详情,请参考 第 4.2 节 “转换为 ext3 文件系统”。

ext4.ko。这意味着,无论使用的 ext 文件系统是什么,内核信息总是指 ext4。

4.1. 创建 ext3 文件系统

- 使用

mkfs.ext3工具使用 ext3 文件系统格式化分区或 LVM 卷:#mkfs.ext3 block_device- 使用到块设备的路径替换 block_device。例如:

/dev/sdb1,/dev/disk/by-uuid/05e99ec8-def1-4a5e-8a9d-5945339ceb2a, 或/dev/my-volgroup/my-lv。

- 使用

e2label工具标记文件系统:#e2label block_device volume_label

配置 UUID

-U 选项:

# mkfs.ext3 -U UUID device- 使用您要设置的 UUID 替换 UUID:例如

7cd65de3-e0be-41d9-b66d-96d749c02da7。 - 使用 ext3 文件系统的路径替换 device,以将 UUID 添加到其中:例如

/dev/sda8。

其它资源

- mkfs.ext3(8) man page

- e2label(8) man page

4.2. 转换为 ext3 文件系统

ext2 文件系统转换为 ext3。

ext2 文件系统转换为 ext3,以 root 身份登录并在终端中输入以下命令:

# tune2fs -j block_device4.3. 恢复回 Ext2 文件系统

/dev/mapper/VolGroup00-LogVol02

过程 4.1. 从 ext3 恢复回 ext2

- 以 root 身份登录,并输入以下内容来卸载分区:

# umount /dev/mapper/VolGroup00-LogVol02 - 输入以下命令将文件系统类型改为 ext2:

# tune2fs -O ^has_journal /dev/mapper/VolGroup00-LogVol02 - 输入以下命令检查分区是否有错误:

# e2fsck -y /dev/mapper/VolGroup00-LogVol02 - 然后,通过输入以下内容将该分区再次挂载为 ext2 文件系统:

# mount -t ext2 /dev/mapper/VolGroup00-LogVol02 /mount/point使用分区的挂载点替换 /mount/point。注意如果分区的根级别存在.journal文件,请将其删除。

/etc/fstab 文件,否则它将在引导后恢复回来。

第 5 章 ext4 文件系统

- 主要功能

- ext4 文件系统使用扩展(与 ext2 和 ext3 使用的传统块映射方案相反),这提高了使用大型文件时的性能,并减少大型文件的元数据开销。此外,ext4 还相应地标记未分配的块组和 inode 表部分,这允许在文件系统检查期间跳过它们。这样可加快文件系统检查的速度,随着文件系统大小的增加,这将变得更加有益。

- 分配功能

- ext4 文件系统具有以下分配方案:

- 持久性预分配

- 延迟分配

- 多块分配

- 条带感知分配

由于延迟分配和其他性能优化,ext4 向磁盘写文件的行为与 ext3 不同。在 ext4 中,当程序写入文件系统时,无法保证为磁盘上,除非程序随后发出 fsync () 调用。默认情况下,ext3 会自动立即将新创建的文件强制到磁盘,即使没有 fsync ()。此行为隐藏了程序中的错误,这些程序不使用 fsync () 来确保写入的数据在磁盘上。另一方面,ext4 文件系统通常会等待几秒钟才能将更改写入磁盘,从而允许它合并并重新排序写操作,以获得比 ext3 更好的磁盘性能。警告与 ext3 不同,ext4 文件系统不会在事务提交时强制数据写到磁盘。因此,将缓冲的写入刷新到磁盘需要更长的时间。与任何文件系统一样,请使用 fsync () 等数据完整性调用来确保数据被写入持久性存储。 - 其他 ext4 功能

- ext4 文件系统还支持以下内容:

- 扩展属性 (

xattr) - 这允许系统为每个文件关联几个额外的名称和值对。 - 配额日志 - 这避免了崩溃后需要冗长的配额一致性检查。注意ext4 中唯一支持的日志模式是 data=ordered (默认)。

- 亚秒时间戳 - 这向亚秒提供时间戳。

5.1. 创建 ext4 文件系统

- 要创建 ext4 文件系统,请使用以下命令:

#mkfs.ext4 block_device- 使用到块设备的路径替换 block_device。例如:

/dev/sdb1,/dev/disk/by-uuid/05e99ec8-def1-4a5e-8a9d-5945339ceb2a, 或/dev/my-volgroup/my-lv。 - 一般说来,默认选项适用于大多数使用场景。

例 5.1. mkfs.ext4 命令输出

~]# mkfs.ext4 /dev/sdb1

mke2fs 1.41.12 (17-May-2010)

Filesystem label=

OS type: Linux

Block size=4096 (log=2)

Fragment size=4096 (log=2)

Stride=0 blocks, Stripe width=0 blocks

245280 inodes, 979456 blocks

48972 blocks (5.00%) reserved for the super user

First data block=0

Maximum filesystem blocks=1006632960

30 block groups

32768 blocks per group, 32768 fragments per group

8176 inodes per group

Superblock backups stored on blocks:

32768, 98304, 163840, 229376, 294912, 819200, 884736

Writing inode tables: done

Creating journal (16384 blocks): done

Writing superblocks and filesystem accounting information: done

条带块设备

- stride=value

- 指定 RAID 块大小。

- stripe-width=value

- 指定 RAID 设备中数据磁盘的数量,或者条带中条带单位的数量。

# mkfs.ext4 -E stride=16,stripe-width=64 /dev/block_device配置 UUID

-U 选项:

# mkfs.ext4 -U UUID device- 使用您要设置的 UUID 替换 UUID:例如

7cd65de3-e0be-41d9-b66d-96d749c02da7。 - 使用 ext4 文件系统的路径替换 device,以将 UUID 添加到其中:例如

/dev/sda8。

其它资源

- mkfs.ext4(8) man page

5.2. 挂载 ext4 文件系统

# mount /dev/device /mount/point

# mount -o acl,user_xattr /dev/device /mount/point

# mount -o data_err=abort /dev/device /mount/point写屏障

# mount -o nobarrier /dev/device /mount/point直接访问技术预览

Direct Access (DAX)提供,作为 ext4 和 XFS 文件系统上的一个技术预览,一个应用程序可以将持久内存直接映射到其地址空间中。要使用 DAX,系统必须有某种可用的持久内存,通常使用一个或多个非线内存模块(NVDIMM),且必须在 NVDIMM 上创建支持 DAX 的文件系统。另外,该文件系统必须使用 dax 挂载选项挂载。然后,在 dax 挂载的文件系统中的一个文件 mmap 会导致存储直接映射到应用程序的地址空间中。

5.3. 重新定义 ext4 文件系统大小

# resize2fs /mount/device size

# resize2fs /dev/device size- s - 512 字节扇区

- K — kilobytes

- M - MB

- G — gigabytes

5.4. 备份 ext2、ext3 或 ext4 文件系统

先决条件

- 如果系统运行了很长时间,请在备份前在分区上运行

e2fsck工具:#e2fsck /dev/device

过程 5.1. 备份 ext2、ext3 或 ext4 文件系统

- 备份配置信息,包括

/etc/fstab文件的内容和 fdisk -l 命令的输出。这对恢复分区非常有用。要捕获这些信息,请运行sosreport或sysreport工具。有关sosreport的更多信息,请参阅 sosreport 是什么以及如何在 Red Hat Enterprise Linux 4.6 及之后的版本中创建?Kdowledgebase 文章。 - 根据分区的角色:

- 如果您要备份的分区是一个操作系统分区,请将您的系统引导至救援模式。请参阅 系统管理员 指南中的引导到救援模式 部分。

- 备份常规的数据分区时,将其卸载。虽然可以在挂载数据时备份数据分区,但备份挂载数据分区的结果可能会无法预测。如果您需要使用

dump实用程序备份挂载的文件系统,当文件系统没有负载过重时,这样做。备份时,文件系统上会出现更多的活动,备份损坏的风险越高。

- 使用

dump程序备份分区的内容:#dump -0uf backup-file /dev/device使用您要存储备份的文件的路径替换 backup-file。使用您要备份的 ext4 分区的名称替换 device。确保您将备份保存到挂载在与您要备份分区不同的分区的目录中。例 5.2. 备份多个 ext4 分区

要将 /dev/sda1、和/dev/sda2/dev/sda3分区的内容备份到存储在/backup-files/目录中的备份文件,请使用以下命令:#dump -0uf /backup-files/sda1.dump /dev/sda1#dump -0uf /backup-files/sda2.dump /dev/sda2#dump -0uf /backup-files/sda3.dump /dev/sda3要执行远程备份,请使用ssh实用程序或配置免密码ssh登录。有关ssh和无密码登录的更多信息,请参阅 系统管理员指南中的使用 ssh 实用程序 和使用基于密钥的身份验证部分。https://access.redhat.com/documentation/zh-cn/red_hat_enterprise_linux/7/html-single/system_administrators_guide/index#s2-ssh-configuration-keypairs例如,在使用ssh时:例 5.3. 使用

ssh执行远程备份#dump -0u -f - /dev/device | ssh root@remoteserver.example.com dd of=backup-file请注意,如果使用标准重定向,则必须单独传递-f选项。

其它资源

- 如需更多信息,请参阅 dump(8) man page。

5.5. 恢复 ext2、ext3 或 ext4 文件系统

先决条件

- 您需要备份分区及其元数据,如 第 5.4 节 “备份 ext2、ext3 或 ext4 文件系统” 所述。

过程 5.2. 恢复 ext2、ext3 或 ext4 文件系统

- 如果您要恢复操作系统分区,请将您的系统引导至救援模式。请参阅 系统管理员 指南中的引导到救援模式 部分。普通数据分区不需要这一步。

- 使用

fdisk或partedutilites 重建您要恢复的分区。如果分区不再存在,重新创建它们。新分区必须足够大以包含恢复的数据。正确获取开始和结束号非常重要;它们是在备份时从fdisk实用程序获取的分区的开始和结束扇区号。有关修改分区的详情,请参考 第 13 章 分区 - 使用

mkfs工具格式化目标分区:#mkfs.ext4 /dev/device重要不要 格式化存储您的备份文件的分区。 - 如果您创建了新分区,请重新标记所有分区,以便它们与

/etc/fstab文件中的条目匹配:#e2label /dev/device label - 创建临时挂载点并在其上挂载分区:

#mkdir /mnt/device#mount -t ext4 /dev/device /mnt/device - 从挂载的分区上的备份中恢复数据:

#cd /mnt/device#restore -rf device-backup-file请注意,您需要为以下命令配置免密码登录。有关设置免密码ssh登录的更多信息,请参阅 系统管理员 指南中的使用基于密钥的身份验证部分。- 从存储在同一台机器上的备份文件恢复远程机器上的分区:

#ssh remote-address "cd /mnt/device && cat backup-file | /usr/sbin/restore -r -f -" - 从存储在不同远程机器上的备份文件恢复远程机器上的分区:

#ssh remote-machine-1 "cd /mnt/device && RSH=/usr/bin/ssh /usr/sbin/restore -rf remote-machine-2:backup-file"

- reboot:

#systemctl reboot

例 5.4. 恢复多个 ext4 分区

- 使用 fdisk 命令重建您要恢复的分区。

- 格式化目标分区:

#mkfs.ext4 /dev/sda1#mkfs.ext4 /dev/sda2#mkfs.ext4 /dev/sda3 - 重新标记所有分区,以便它们与

/etc/fstab文件匹配:#e2label /dev/sda1 Boot1#e2label /dev/sda2 Root#e2label /dev/sda3 Data - 准备工作目录。挂载新分区:

#mkdir /mnt/sda1#mount -t ext4 /dev/sda1 /mnt/sda1#mkdir /mnt/sda2#mount -t ext4 /dev/sda2 /mnt/sda2#mkdir /mnt/sda3#mount -t ext4 /dev/sda3 /mnt/sda3挂载包含备份文件的分区:#mkdir /backup-files#mount -t ext4 /dev/sda6 /backup-files - 将数据从备份恢复到挂载的分区:

#cd /mnt/sda1#restore -rf /backup-files/sda1.dump#cd /mnt/sda2#restore -rf /backup-files/sda2.dump#cd /mnt/sda3#restore -rf /backup-files/sda3.dump - reboot:

#systemctl reboot

其它资源

- 如需更多信息,请参阅 restore(8) man page。

5.6. 其他 ext4 文件系统实用程序

- e2fsck

- 用于修复 ext4 文件系统.由于 ext4 磁盘结构的更新,此工具对 ext4 文件系统的检查和修复比对 ext3 更高效。

- e2label

- 更改 ext4 文件系统上的标签。此工具也适用于 ext2 和 ext3 文件系统。

- quota

- fsfreeze

- 要暂停对文件系统的访问,请使用命令 # fsfreeze -f mount-point 来冻结它,而 # fsfreeze -u mount-point to unfreeze it。这会停止对文件系统的访问,并在磁盘上创建稳定的镜像。注意对于设备映射器驱动器,不需要使用 fsfreeze。如需更多信息,请参阅 fsfreeze (8) 手册页。

- debugfs

- 调试 ext2、ext3 或 ext4 文件系统。

- e2image

- 将重要的 ext2、ext3 或 ext4 文件系统元数据保存到文件中。

第 6 章 Btrfs(技术预览)

6.1. 创建 btrfs 文件系统

# mkfs.btrfs /dev/device6.2. 挂载 btrfs 文件系统

# mount /dev/device /mount-point

- device=/dev/name

- 在 mount 命令中附加这个选项会告知 btrfs 扫描指定设备的 btrfs 卷。这用于确保挂载成功,因为尝试挂载不是 btrfs 的设备将导致挂载失败。注意这并不意味着所有设备都会添加到文件系统中,它只扫描它们。

- max_inline=number

- 使用此选项设置可用于元数据 B-tree leaf 中的内联数据的最大空间量(以字节为单位)。默认值为 8192 字节。对于 4k 页,它会被限制为 3900 字节,因为额外的标头需要容纳到 leaf。

- alloc_start=number

- 使用这个选项设置磁盘分配开始的位置。

- thread_pool=number

- 使用这个选项分配分配的 worker 线程数量。

- discard

- 使用这个选项在空闲块中启用 discard/TRIM。

- noacl

- 使用这个选项禁用 ACL 的使用。

- space_cache

- 使用这个选项将可用空间数据存储在磁盘上,以便更快地缓存块组。这是一个持久的更改,可以安全地引导到旧内核。

- nospace_cache

- 使用这个选项禁用上述 space_cache。

- clear_cache

- 使用这个选项清除挂载期间的所有可用空间缓存。这是一个安全的选项,但将触发要重新构建的空间缓存。因此,让文件系统保持挂载,以便重建过程完成。这个挂载选项旨在被使用一次,且仅在问题出现可用空间后才被使用。

- enospc_debug

- 这个选项用于调试"无空格"的问题。

- recovery

- 使用这个选项在挂载时启用自动恢复。

6.3. 调整 btrfs 文件系统的大小

放大 btrfs 文件系统

# btrfs filesystem resize amount /mount-point

# btrfs filesystem resize +200M /btrfssingle Resize '/btrfssingle' of '+200M'

# btrfs filesystem show /mount-point

# btrfs filesystem show /btrfstest Label: none uuid: 755b41b7-7a20-4a24-abb3-45fdbed1ab39 Total devices 4 FS bytes used 192.00KiB devid 1 size 1.00GiB used 224.75MiB path /dev/vdc devid 2 size 524.00MiB used 204.75MiB path /dev/vdd devid 3 size 1.00GiB used 8.00MiB path /dev/vde devid 4 size 1.00GiB used 8.00MiB path /dev/vdf Btrfs v3.16.2

devid 后,使用以下命令:

# btrfs filesystem resize devid:amount /mount-point

# btrfs filesystem resize 2:+200M /btrfstest Resize '/btrfstest/' of '2:+200M'

缩小 btrfs 文件系统

# btrfs filesystem resize amount /mount-point

# btrfs filesystem resize -200M /btrfssingle Resize '/btrfssingle' of '-200M'

# btrfs filesystem show /mount-point

# btrfs filesystem show /btrfstest Label: none uuid: 755b41b7-7a20-4a24-abb3-45fdbed1ab39 Total devices 4 FS bytes used 192.00KiB devid 1 size 1.00GiB used 224.75MiB path /dev/vdc devid 2 size 524.00MiB used 204.75MiB path /dev/vdd devid 3 size 1.00GiB used 8.00MiB path /dev/vde devid 4 size 1.00GiB used 8.00MiB path /dev/vdf Btrfs v3.16.2

devid 后,使用以下命令:

# btrfs filesystem resize devid:amount /mount-point

# btrfs filesystem resize 2:-200M /btrfstest Resize '/btrfstest' of '2:-200M'

设置文件系统大小

# btrfs filesystem resize amount /mount-point

# btrfs filesystem resize 700M /btrfssingle Resize '/btrfssingle' of '700M'

# btrfs filesystem show /mount-point

# btrfs filesystem show /btrfstest Label: none uuid: 755b41b7-7a20-4a24-abb3-45fdbed1ab39 Total devices 4 FS bytes used 192.00KiB devid 1 size 1.00GiB used 224.75MiB path /dev/vdc devid 2 size 724.00MiB used 204.75MiB path /dev/vdd devid 3 size 1.00GiB used 8.00MiB path /dev/vde devid 4 size 1.00GiB used 8.00MiB path /dev/vdf Btrfs v3.16.2

devid 后,使用以下命令:

# btrfs filesystem resize devid:amount /mount-point

# btrfs filesystem resize 2:300M /btrfstest Resize '/btrfstest' of '2:300M'

6.4. 多个设备的集成卷管理

6.4.1. 创建使用多个设备的文件系统

- raid0

- raid1

- raid10

- dup

- 单个

例 6.1. 创建 RAID 10 btrfs 文件系统

# mkfs.btrfs /dev/device1 /dev/device2 /dev/device3 /dev/device4

# mkfs.btrfs -m raid0 /dev/device1 /dev/device2

# mkfs.btrfs -m raid10 -d raid10 /dev/device1 /dev/device2 /dev/device3 /dev/device4

# mkfs.btrfs -m single /dev/device

# mkfs.btrfs -d single /dev/device1 /dev/device2 /dev/device3

# btrfs device add /dev/device1 /mount-point

6.4.2. 扫描 btrfs 设备

/dev 下的所有块设备,并探测 btrfs 卷。如果在文件系统中有多个设备运行时,则必须在载入 btrfs 模块后执行此操作。

# btrfs device scan

# btrfs device scan /dev/device

6.4.3. 在 btrfs 文件系统中添加新设备

例 6.2. 在 btrfs 文件系统中添加新设备

# mkfs.btrfs /dev/device1 # mount /dev/device1

# btrfs device add /dev/device2 /mount-point

/dev/device1 中。现在,它必须平衡才能分散到所有设备上。

# btrfs filesystem balance /mount-point

6.4.4. 转换 btrfs 文件系统

例 6.3. 转换 btrfs 文件系统

/dev/sdb 1)转换为两个设备,raid1 系统以便防止单个磁盘失败,请使用以下命令:

# mount /dev/sdb1 /mnt # btrfs device add /dev/sdc1 /mnt # btrfs balance start -dconvert=raid1 -mconvert=raid1 /mnt

6.4.5. 删除 btrfs 设备

例 6.4. 删除 btrfs 文件系统上的设备

# mkfs.btrfs /dev/sdb /dev/sdc /dev/sdd /dev/sde # mount /dev/sdb /mnt

# btrfs device delete /dev/sdc /mnt

6.4.6. 在 btrfs 文件系统中替换失败的设备

# mkfs.btrfs -m raid1 /dev/sdb /dev/sdc /dev/sdd /dev/sde ssd is destroyed or removed, use -o degraded to force the mount to ignore missing devices # mount -o degraded /dev/sdb /mnt 'missing' is a special device name # btrfs device delete missing /mnt

- 以 degraded 模式挂载,

- 添加新设备,

- 和 删除缺少的设备。

6.4.7. 在 /etc/fstab中注册 btrfs 文件系统

initrd 或它没有执行 btrfs 设备扫描,则可以通过将文件系统中所有设备明确传递给 mount 命令来挂载多卷 btrfs 文件系统。

例 6.5. /etc/fstab 条目示例

/etc/fstab 条目示例为:

/dev/sdb /mnt btrfs device=/dev/sdb,device=/dev/sdc,device=/dev/sdd,device=/dev/sde 0

6.5. SSD 优化

mkfs.btrfs,在单个设备上为 /sys/block/设备/queue/rotational 关闭元数据重复。这等同于在命令行中指定 -m single。它可以通过提供 -m dup 选项来覆盖和重复元数据。由于 SSD 固件可能会丢失两个副本,因此不需要重复。这种浪费空间是性能成本。

- 它允许更大的元数据集群分配。

- 它尽可能顺序分配数据。

- 它禁用 btree leaf rewting 来匹配密钥和块顺序。

- 它在不批量多个进程的情况下提交日志片段。

6.6. Btrfs 参考

- 用于管理快照的所有子卷命令。

- 用于管理

设备的设备命令。 - 清理、平衡、平衡 和 碎片整理 命令。

第 7 章 全局文件系统 2

gfs2.ko 内核模块实现 GFS2 文件系统,并加载在 GFS2 集群节点上。

第 8 章 网络文件系统 (NFS)

8.1. NFS 简介

- NFS 版本 3 (NFSv3)支持安全异步写入,并在处理错误时比之前的 NFSv2 更强大。它还支持 64 位文件大小和偏移量,允许客户端访问超过 2 GB 的文件数据。

- NFS 版本 4 (NFSv4)通过防火墙,并在 Internet 上工作,不再需要 rpcbind 服务,支持 ACL,并且使用有状态操作。

- 稀疏文件 :它验证文件的空间效率,并允许占位符提高存储效率。它是具有一个或多个漏洞的文件;漏洞是未分配的或未初始化的数据块,仅包含零。

lseek()NFSv4.2 中的操作支持seek_hole()和seek_data(),它允许应用程序在稀疏文件中映射漏洞的位置。 - 空间保留:它允许存储服务器保留空闲空间,从而禁止服务器耗尽空间。NFSv4.2 支持

allocate()操作来保留空间、deallocate()操作,以及fallocate()操作来预分配或取消分配文件中的空间。 - 标记的 NFS:它会强制实施数据访问权限,并为 NFS 文件系统上的单个文件在客户端和服务器之间启用 SELinux 标签。

- 布局增强:NFSv4.2 提供新的操作

layoutstats(),客户端可以使用它来通知元数据服务器有关其与布局的通信。

- 提高了网络的性能和安全性,还包括对并行 NFS (pNFS)的客户端支持。

- 对于回调不再需要单独的 TCP 连接,这允许 NFS 服务器授予委托,即使它无法联系客户端。例如,当 NAT 或防火墙干扰时。

- 它只提供一次语义(除重启操作外),防止之前的问题,当回复丢失并且操作被发送两次时,某些操作可能会返回不准确的结果。

/etc/exports 配置文件,以确定是否允许客户端访问任何导出的文件系统。一旦被验证,所有文件和目录操作都对用户有效。

8.1.1. 所需的服务

- nfs

- systemctl start nfs 启动 NFS 服务器,以及为共享 NFS 文件系统请求提供服务的适当 RPC 进程。

- nfslock

- systemctl start nfs-lock 激活一个强制服务,该服务启动适当的 RPC 进程,允许 NFS 客户端锁定服务器上的文件。

- rpcbind

- rpcbind 接受本地 RPC 服务的端口保留。这些端口随后可用(或发布),以便相应的远程 RPC 服务可以访问它们。rpcbind 响应对 RPC 服务的请求,并设置到请求的 RPC 服务的连接。这不能与 NFSv4 一起使用。

- rpc.mountd

- NFS 服务器使用这个进程来处理来自 NFSv3 客户端的 MOUNT 请求。它检查所请求的 NFS 共享是否目前由 NFS 服务器导出,并且允许客户端访问它。如果允许挂载请求,rpc.mountd 服务器会以

Success状态回复,并将这个 NFS 共享的文件处理返回给 NFS 客户端。 - rpc.nfsd

- rpc.nfsd 允许定义服务器公告的显式 NFS 版本和协议。它与 Linux 内核配合使用,以满足 NFS 客户端的动态需求,例如在每次 NFS 客户端连接时提供服务器线程。这个进程对应于 nfs 服务。

- lockd

- lockd 是一个在客户端和服务器上运行的内核线程。它实现了 网络锁定管理器 (NLM)协议,它允许 NFSv3 客户端锁定服务器上的文件。每当运行 NFS 服务器以及挂载 NFS 文件系统时,它会自动启动。

- rpc.statd

- 这个进程实现 网络状态监控器 (NSM)RPC 协议,该协议在 NFS 服务器没有正常关闭而重新启动时,通知 NFS 客户端。RPC.statd 由 nfslock 服务自动启动,不需要用户配置。这不能与 NFSv4 一起使用。

- rpc.rquotad

- 这个过程为远程用户提供用户配额信息。RPC.rquotad 由 nfs 服务自动启动,不需要用户配置。

- rpc.idmapd

- rpc.idmapd 提供 NFSv4 客户端和服务器上调用,这些调用在线 NFSv4 名称(以

user@domain形式的字符串)和本地 UID 和 GID 之间进行映射。要使 idmapd 与 NFSv4 正常工作,必须配置/etc/idmapd.conf文件。至少应指定"Domain"参数,该参数定义 NFSv4 映射域。如果 NFSv4 映射域与 DNS 域名相同,可以跳过这个参数。客户端和服务器必须同意 NFSv4 映射域才能使 ID 映射正常工作。注意在 Red Hat Enterprise Linux 7 中,只有 NFSv4 服务器使用 rpc.idmapd。NFSv4 客户端使用基于密钥环的 idmapper nfsidmap。nfsidmap 是一个独立程序,由内核按需调用来执行 ID 映射;它不是一个守护进程。如果 nfsidmap 出现问题,客户端会回退到使用 rpc.idmapd。有关 nfsidmap 的更多信息,请参阅 nfsidmap 手册页。

8.2. 配置 NFS 客户端

# mount -t nfs -o options server:/remote/export /local/directory- options

- 以逗号分隔的挂载选项列表 ; 有关有效 NFS 挂载选项的详情,请参考 第 8.4 节 “常用 NFS 挂载选项”。

- server

- 导出您要挂载的文件系统的服务器的主机名、IP 地址或完全限定域名

- /remote/export

- 从 server 导出的文件系统或目录,即您要挂载的目录

- /local/directory

- 挂载 /remote/export 的客户端位置

/etc/fstab 文件和 autofs 服务。如需更多信息,请参阅 第 8.2.1 节 “使用 /etc/fstab挂载 NFS 文件系统” 和 第 8.3 节 “autofs”。

8.2.1. 使用 /etc/fstab挂载 NFS 文件系统

/etc/fstab 文件中添加一行。行必须指定 NFS 服务器的主机名、要导出的服务器上的目录,以及 NFS 共享要挂载在本地计算机上的目录。您必须是 root 用户才能修改 /etc/fstab 文件。

例 8.1. 语法示例

/etc/fstab 中行的一般语法如下:

server:/usr/local/pub /pub nfs defaults 0 0

/pub。将这一行添加到客户端系统上的 /etc/fstab 后,使用命令 mount /pub,挂载点 /pub 是从服务器挂载的。

/etc/fstab 条目应包含以下信息:

server:/remote/export /local/directory nfs options 0 0

/etc/fstab 之前,客户端上必须存在挂载点 /local/directory。否则,挂载会失败。

/etc/fstab 后,重新生成挂载单元,以便您的系统注册新配置:

# systemctl daemon-reload其它资源

- 有关

/etc/fstab的详情,请参考 man fstab。

8.3. autofs

/etc/fstab 的一个缺点是,无论用户如何经常访问 NFS 挂载的文件系统,系统都必须指定资源来保持挂载的文件系统。对于一个或两个挂载没有问题,但当系统一次维护多个系统的挂载时,整体的系统性能可能会受到影响。/etc/fstab 的替代方法是使用基于内核的 automount 工具。自动挂载程序由两个组件组成:

- 实现文件系统的内核模块,以及

- 执行所有其他功能的用户空间守护进程。

/etc/auto.master (主映射)作为其默认主配置文件。可以使用 autofs 配置(在 /etc/sysconfig/autofs中)与名称服务交换机(NSS)机制结合使用其他支持的网络源和名称。为主映射中配置的每个挂载点运行一个 autofs 版本 4 守护进程的实例,因此可以在命令行中针对任何给定挂载点手动运行。autofs 版本 5 无法实现,因为它使用单个守护进程来管理所有配置的挂载点;因此,必须在主映射中配置所有自动挂载。这符合其他行业标准自动挂载程序的常规要求。挂载点、主机名、导出的目录和选项都可以在一组文件(或其他支持的网络源)中指定,而不必为每个主机手动配置它们。

8.3.1. 相对于版本 4 , autofs 版本 5 的改进

- 直接映射支持

- autofs 中的直接映射提供了一种在文件系统层次结构中的任意点自动挂载文件系统的机制。直接映射由主映射中的挂载点

/-表示。直接映射中的条目包含一个作为键的绝对路径名称(而不是间接映射中使用的相对路径名称)。 - Lazy 挂载和卸载支持

- 多挂载映射条目描述了单个键下的挂载点层次结构。一个很好的例子是

-hosts映射,通常用于将主机/net/主机中的所有导出自动挂载为多挂载映射条目。使用-hosts映射时,/net/主机的 ls 将为每个来自 主机 的导出挂载 autofs 触发器挂载。然后,它们将在被访问时进行挂载并使其过期。这可大幅减少访问具有大量导出的服务器时所需的活动挂载数量。 - 增强的 LDAP 支持

- autofs 配置文件(

/etc/sysconfig/autofs)提供了一种机制来指定站点实施的 autofs 模式,从而防止在应用程序本身中通过试用和错误来确定这一点。此外,现在支持对 LDAP 服务器进行身份验证的绑定,使用常见 LDAP 服务器实现支持的大多数机制。为此支持添加了一个新的配置文件:/etc/autofs_ldap_auth.conf。默认的配置文件是自文档文件,使用 XML 格式。 - 正确使用名称服务切换(nsswitch)配置。

- 名称服务切换配置文件的存在是为了提供一种方法来确定特定的配置数据来自哪里。这种配置的原因是让管理员可以灵活地使用选择的后端数据库,同时维护统一的软件接口来访问数据。尽管在处理 NSS 配置时,版本 4 自动挂载程序变得越来越好,但它仍然不完整。另一方面,autofs 版本 5 是一个完整的实现。有关此文件支持的语法的更多信息,请参阅 man nsswitch.conf。并非所有 NSS 数据库都是有效的映射源,解析器将拒绝无效的映射源。有效的源是 file, yp,nis,nisplus,ldap, 和 hesiod。

- 每个 autofs 挂载点都有多个主映射条目

- 经常使用但还没有提及的一件事是处理直接挂载点

/-的多个主映射条目。每个条目的映射键被合并,并表现为一个映射的形式。例 8.2. 每个 autofs 挂载点都有多个主映射条目

以下是直接挂载的 connectathon 测试映射中的示例:/- /tmp/auto_dcthon /- /tmp/auto_test3_direct /- /tmp/auto_test4_direct

8.3.2. 配置 autofs

/etc/auto.master,也称为主映射,如 第 8.3.1 节 “相对于版本 4 , autofs 版本 5 的改进” 所述。主映射列出了系统上 autofs- 控制的挂载点,以及它们相应的配置文件或网络来源,称为自动挂载映射。master 映射的格式如下:

mount-point map-name options

- mount-point

- 例如,autofs 挂载点

/home。 - map-name

- 包含挂载点列表的映射源的名称,以及挂载这些挂载点的文件系统的位置。

- options

- 如果提供,它们适用于给定映射中的所有条目,只要它们本身没有指定选项。这个行为与 autofs 版本 4 不同,其中选项是累积的。这已被修改来实现混合环境兼容性。

例 8.3. /etc/auto.master 文件

/etc/auto.master 文件的示例行(使用 cat /etc/auto.master显示):

/home /etc/auto.misc

mount-point [options] location

- mount-point

- 这指的是 autofs 挂载点。这可以是间接挂载的单个目录名称,也可以是直接挂载的挂载点的完整路径。每个直接和间接映射条目键(挂载点)后面可以跟一个以空格分隔的偏移目录列表(每个以

/开头的子目录名称)使其称为多挂载条目。 - options

- 每当提供时,这些都是未指定其自身选项的映射条目的挂载选项。

- 位置

- 这指的是文件系统位置,如本地文件系统路径(对于以

/开头的映射名称,前面带有 Sun 映射格式转义字符":")、NFS 文件系统或其他有效的文件系统位置。

/etc/auto.misc)中的内容示例:

payroll -fstype=nfs personnel:/dev/hda3 sales -fstype=ext3 :/dev/hda4

sales 和 payroll )。第二列显示 autofs 挂载的选项,第三列则指示挂载的来源。在给定配置后,autofs 挂载点将是 /home/payroll 和 /home/sales。通常省略 -fstype= 选项,通常不需要正确的操作。

# systemctl start autofs# systemctl restart autofs/home/payroll/2006/July.sxc,则自动挂载守护进程会自动挂载该目录。如果指定了超时,则如果在超时时间内没有访问该目录,则目录会被自动卸载。

# systemctl status autofs8.3.3. 覆盖或增加站点配置文件

- 自动挂载程序映射存储在 NIS 中,

/etc/nsswitch.conf文件具有以下指令:automount: files nis

auto.master文件包含:+auto.master

- NIS

auto.master映射文件包含:/home auto.home

- NIS

auto.home映射包含:beth fileserver.example.com:/export/home/beth joe fileserver.example.com:/export/home/joe * fileserver.example.com:/export/home/&

- 文件映射

/etc/auto.home不存在。

auto.home 并从其他服务器挂载主目录。在这种情况下,客户端需要使用以下 /etc/auto.master 映射:

/home /etc/auto.home +auto.master

/etc/auto.home 映射包含条目:

* labserver.example.com:/export/home/&

/home 包含 /etc/auto.home 的内容,而不是 NIS auto.home 映射。

auto.home 映射,请创建一个 /etc/auto.home 文件映射,并在其中放置新条目。在结尾处,包含 NIS auto.home 映射。然后 /etc/auto.home 文件映射类似:

mydir someserver:/export/mydir +auto.home

auto.home 映射条件时,ls /home 命令输出:

beth joe mydir

8.3.4. 使用 LDAP 来存储自动挂载程序映射

openldap 软件包应作为 自动挂载程序 的依赖项自动安装。要配置 LDAP 访问,请修改 /etc/openldap/ldap.conf。确保为您的站点正确设置了 BASE、URI 和 模式。

rfc2307bis 描述了在 LDAP 中存储自动挂载映射的最新建立的模式。要使用此模式,必须通过从架构定义中删除注释字符,在 autofs 配置(/etc/sysconfig/autofs)中设置它。例如:

例 8.4. 设置 autofs 配置

DEFAULT_MAP_OBJECT_CLASS="automountMap" DEFAULT_ENTRY_OBJECT_CLASS="automount" DEFAULT_MAP_ATTRIBUTE="automountMapName" DEFAULT_ENTRY_ATTRIBUTE="automountKey" DEFAULT_VALUE_ATTRIBUTE="automountInformation"

rfc2307bis 模式中的 cn 属性。以下是 LDAP 数据交换格式(LDIF)配置示例:

例 8.5. LDF 配置

# extended LDIF # # LDAPv3 # base <> with scope subtree # filter: (&(objectclass=automountMap)(automountMapName=auto.master)) # requesting: ALL # # auto.master, example.com dn: automountMapName=auto.master,dc=example,dc=com objectClass: top objectClass: automountMap automountMapName: auto.master # extended LDIF # # LDAPv3 # base <automountMapName=auto.master,dc=example,dc=com> with scope subtree # filter: (objectclass=automount) # requesting: ALL # # /home, auto.master, example.com dn: automountMapName=auto.master,dc=example,dc=com objectClass: automount cn: /home automountKey: /home automountInformation: auto.home # extended LDIF # # LDAPv3 # base <> with scope subtree # filter: (&(objectclass=automountMap)(automountMapName=auto.home)) # requesting: ALL # # auto.home, example.com dn: automountMapName=auto.home,dc=example,dc=com objectClass: automountMap automountMapName: auto.home # extended LDIF # # LDAPv3 # base <automountMapName=auto.home,dc=example,dc=com> with scope subtree # filter: (objectclass=automount) # requesting: ALL # # foo, auto.home, example.com dn: automountKey=foo,automountMapName=auto.home,dc=example,dc=com objectClass: automount automountKey: foo automountInformation: filer.example.com:/export/foo # /, auto.home, example.com dn: automountKey=/,automountMapName=auto.home,dc=example,dc=com objectClass: automount automountKey: / automountInformation: filer.example.com:/export/&

8.4. 常用 NFS 挂载选项

/etc/fstab 设置和 autofs。

- lookupcache=mode

- 指定内核应该如何管理给定挂载点的目录条目缓存。模式 的有效参数为

all、none或pos/positive。 - nfsvers=version

- 指定要使用的 NFS 协议版本,其中 version 为 3 或 4。这对于运行多个 NFS 服务器的主机很有用。如果没有指定版本,NFS 将使用内核和 mount 命令支持的最高版本。选项 vers 等同于 nfsvers ,出于兼容性的原因包含在此发行版本中。

- noacl

- 关闭所有 ACL 处理。当与旧版本的 Red Hat Enterprise Linux、Red Hat Linux 或 Solaris 交互时,可能会需要此功能,因为最新的 ACL 技术与较旧的系统不兼容。

- nolock

- 禁用文件锁定。当连接到非常旧的 NFS 服务器时,有时需要这个设置。

- noexec

- 防止在挂载的文件系统中执行二进制文件。这在系统挂载不兼容二进制文件的非 Linux 文件系统时有用。

- nosuid

- 禁用

set-user-identifier或set-group-identifier位。这可防止远程用户通过运行 setuid 程序获得更高的特权。 - port=num

- 指定 NFS 服务器端口的数字值。如果 num 是 0 ( 默认值),则 mount 会查询远程主机的 rpcbind 服务,以获取要使用的端口号。如果远程主机的 NFS 守护进程没有注册到其 rpcbind 服务,则会使用标准 NFS 端口号 TCP 2049。

- rsize=num 和 wsize=num

- 这些选项设定在单个 NFS 读取或写入操作中传输的最大字节数。

rsize和wsize没有固定的默认值。默认情况下,NFS 使用服务器和客户端都支持的最大的可能值。在 Red Hat Enterprise Linux 7 中,客户端和服务器的最大值为 1,048,576 字节。详情请查看 rsize 和 wsize 的默认和最大值是什么?Kbase 文章。 - sec=flavors

- 用于访问挂载导出上文件的安全类别。flavors 值是以冒号分隔的一个或多个安全类型列表。默认情况下,客户端会尝试查找客户端和服务器都支持的安全类别。如果服务器不支持任何选定的类别,挂载操作将失败。

sec=sys使用本地 UNIX UID 和 GID。它们使用AUTH_SYS验证 NFS 操作。sec=krb5使用 Kerberos V5 ,而不是本地 UNIX UID 和 GID 来验证用户。sec=krb5i使用 Kerberos V5 进行用户身份验证,并使用安全校验和执行 NFS 操作的完整性检查,以防止数据被篡改。sec=krb5p使用 Kerberos V5 进行用户身份验证、完整性检查,并加密 NFS 流量以防止流量嗅探。这是最安全的设置,但它也会涉及最大的性能开销。 - tcp

- 指示 NFS 挂载使用 TCP 协议。

- udp

- 指示 NFS 挂载使用 UDP 协议。

8.5. 启动和停止 NFS 服务器

先决条件

$systemctl status rpcbind要配置只使用 NFSv4 的服务器,它不需要rpcbind,请参阅 第 8.6.7 节 “配置只使用 NFSv4 的服务器”。- 在 Red Hat Enterprise Linux 7.0 中,如果您的 NFS 服务器导出 NFSv3 并在引导时启用,则需要手动启动并启用

nfs-lock服务:#systemctl start nfs-lock#systemctl enable nfs-lock在 Red Hat Enterprise Linux 7.1 及更高版本中,如果需要,nfs-lock会自动启动,并尝试手动启用它。

流程

- 要启动 NFS 服务器,请使用以下命令:

# systemctl start nfs - 要使 NFS 在引导时启动,请使用以下命令:

# systemctl enable nfs - 要停止服务器,请使用:

# systemctl stop nfs restart选项是停止然后启动 NFS 的简写方式。这是编辑 NFS 配置文件后使配置更改生效的最有效方式。要重启服务器的类型:# systemctl restart nfs- 编辑

/etc/sysconfig/nfs文件后,运行以下命令来重启 nfs-config 服务,使新值生效:# systemctl restart nfs-config try-restart命令仅在当前正在运行时启动 nfs。此命令等同于 Red Hat init 脚本中的 condrestart (有条件重启)非常有用,因为它不会在 NFS 未运行时启动守护进程。要有条件地重启服务器,请输入:# systemctl try-restart nfs- 要在不重启服务类型的情况下重新载入 NFS 服务器配置文件:

# systemctl reload nfs

8.6. 配置 NFS 服务器

- 手动编辑 NFS 配置文件,即

/etc/exports,以及 - 通过命令行,即使用 exportfs命令

8.6.1. /etc/exports 配置文件

/etc/exports 文件控制哪些文件系统被导出到远程主机,并指定选项。它遵循以下语法规则:

- 空白行将被忽略。

- 要添加注释,以井号(#)开始一行。

- 您可以使用反斜杠(\)换行长行。

- 每个导出的文件系统都应该独立。

- 所有在导出的文件系统后放置的授权主机列表都必须用空格分开。

- 每个主机的选项必须在主机标识符后直接放在括号中,没有空格分离主机和第一个括号。

export host(options)

- export

- 导出的目录

- host

- 导出要共享的主机或网络

- options

- 用于 host 的选项

export host1(options1) host2(options2) host3(options3)

/etc/exports 文件只指定导出的目录和允许访问它的主机,如下例所示:

例 8.6. /etc/exports 文件

/exported/directory bob.example.com

bob.example.com 可以从 NFS 服务器挂载 /exported/directory/。因为在这个示例中没有指定选项,所以 NFS 将 使用默认设置。

- ro

- 导出的文件系统是只读的。远程主机无法更改文件系统中共享的数据。要允许主机更改文件系统(即读写),请指定

rw选项。 - 同步

- 在将之前的请求所做的更改写入磁盘前,NFS 服务器不会回复请求。要启用异步写入,请指定

async选项。 - wdelay

- 如果 NFS 服务器预期另外一个写入请求即将发生,则 NFS 服务器会延迟写入磁盘。这可以提高性能,因为它可减少不同的写命令访问磁盘的次数,从而减少写开销。要禁用此功能,请指定

no_wdelay。只有指定了默认的sync选项时,no_wdelay才可用。 - root_squash

- 这可防止远程连接的 root 用户(而不是本地)具有 root 权限;相反,NFS 服务器会为他们分配用户 ID

nfsnobody。这可以有效地将远程 root 用户的权限"挤压"成最低的本地用户,从而防止在远程服务器上可能的未经授权的写操作。要禁用 root 压缩,请指定no_root_squash。

all_squash :要指定 NFS 服务器应该分配给来自特定主机的远程用户的用户 ID 和组 ID,请分别使用 anonuid 和 anongid 选项,如下所示:

export host(anonuid=uid,anongid=gid)

anonuid 和 anongid 选项允许您创建特殊的用户和组帐户,为远程 NFS 用户共享。

rw 选项,则导出的文件系统将以只读形式共享。以下是 /etc/exports 中的示例行,其覆盖两个默认选项:

/another/exported/directory/ 读写,对磁盘的所有写入都是异步的。有关导出选项的更多信息,请参阅 man exportfs。

/etc/exports 文件的格式要求非常精确,特别是在空格字符的使用方面。需要将导出的文件系统与主机、不同主机间使用空格分隔。但是,除了注释行外,文件中不应该包括其他空格。

/home bob.example.com(rw) /home bob.example.com (rw)

bob.example.com 中的用户对 /home 目录进行读写访问。第二行允许来自 bob.example.com 的用户以只读方式挂载目录(默认),而其他用户可以将其挂载为读/写。

8.6.2. exportfs 命令

/etc/exports 文件中。当 nfs 服务启动时,/usr/sbin/exportfs 命令启动并读取此文件,将控制传递给实际挂载进程的 rpc.mountd (如果 NFSv3),然后传给 rpc.nfsd,然后供远程用户使用。

/var/lib/nfs/xtab。由于 rpc.mountd 在决定对文件系统的访问权限时引用 xtab 文件,因此对导出的文件系统列表的更改会立即生效。

- -r

- 通过在

/var/lib/nfs/etab中构建新的导出列表,将/etc/exports中列出的所有目录导出。如果对/etc/exports做了任何更改,这个选项可以有效地刷新导出列表。 - -a

- 根据将哪些其他选项传给 /usr/sbin/exportfs,导致所有目录被导出或取消导出。如果没有指定其他选项,/usr/sbin/exportfs 会导出

/etc/exports中指定的所有文件系统。 - -o file-systems

- 指定没有在

/etc/exports中列出的要导出的目录。将 file-systems 替换为要导出的其它文件系统。这些文件系统的格式化方式必须与/etc/exports中指定的方式相同。此选项通常用于在将导出的文件系统永久添加到导出的文件系统列表之前,对其进行测试。有关/etc/exports语法的详情,请参考 第 8.6.1 节 “/etc/exports配置文件”。 - -i

- 忽略

/etc/exports;只有命令行上指定的选项才会用于定义导出的文件系统。 - -u

- 不导出所有共享目录。命令 /usr/sbin/exportfs -ua 可暂停 NFS 文件共享,同时保持所有 NFS 守护进程正常运行。要重新启用 NFS 共享,请使用 exportfs -r。

- -v

- 详细操作,当执行 exportfs 命令时,更详细地显示正在导出的或取消导出的文件系统。

8.6.2.1. 使用带有 NFSv4 的 exportfs

/etc/sysconfig/nfs 中设置 RPCNFSDARGS= -N 4 来将其关闭。

8.6.3. 在防火墙后面运行 NFS

/etc/sysconfig/nfs 文件来设置 RPC 服务运行的端口。要允许客户端通过防火墙访问 RPC 配额,请参阅 第 8.6.4 节 “通过防火墙访问 RPC 配额”。

/etc/sysconfig/nfs 文件在所有系统中都不存在。如果 /etc/sysconfig/nfs 不存在,请创建并指定以下内容:

- RPCMOUNTDOPTS="-p port"

- 这会将"-p port"添加到 rpc.mount 命令行: rpc.mount -p port。

nlockmgr 服务使用的端口,请在 /etc/modprobe.d/lockd.conf 文件中设置 nlm_tcpport 和 nlm_udpport 选项的端口号。

/var/log/messages。通常,如果指定了已在使用的端口号,NFS 将无法启动。编辑 /etc/sysconfig/nfs 后,您需要重启 nfs-config 服务,以便新值在 Red Hat Enterprise Linux 7.2 中生效,然后再运行以下命令:

# systemctl restart nfs-config

然后,重启 NFS 服务器:

# systemctl restart nfs-server

运行 rpcinfo -p 以确认更改生效。

/proc/sys/fs/nfs/nfs_callback_tcpport,并允许服务器连接到客户端上的该端口。

mountd、statd 和 lockd 的其他端口。

8.6.3.1. 发现 NFS 导出

- 在支持 NFSv3 的任何服务器上,使用 showmount 命令:

$showmount -e myserver Export list for mysever /exports/foo /exports/bar - 在支持 NFSv4 的任何服务器上,挂载 根目录并查找。

#mount myserver:/ /mnt/#cd /mnt/ exports#ls exports foo bar

8.6.4. 通过防火墙访问 RPC 配额

过程 8.1. 使 RPC 配额访问防火墙不可行

- 要启用

rpc-rquotad服务,请使用以下命令:#systemctl enable rpc-rquotad - 要启动

rpc-rquotad服务,请使用以下命令:

请注意,如果启用#systemctl start rpc-rquotadrpc-rquotad,则自动启动nfs-server服务。 - 要使配额 RPC 服务在防火墙后面访问,需要打开 UDP 或 TCP 端口

875。默认端口号定义在/etc/services文件中。您可以通过将-p port-number附加到/etc/sysconfig/rpc-rquotad文件中的RPCRQUOTADOPTS变量来覆盖默认端口号。 - 重启

rpc-rquotad以使/etc/sysconfig/rpc-rquotad文件中的更改生效:#systemctl restart rpc-rquotad

从远程主机设置配额

-S 选项附加到 /etc/sysconfig/rpc-rquotad 文件中的 RPCRQUOTADOPTS 变量中。

rpc-rquotad 以使 /etc/sysconfig/rpc-rquotad 文件中的更改生效:

# systemctl restart rpc-rquotad

8.6.5. 主机名格式

- 单台机器

- 完全限定域名(可由服务器解析)、主机名(可由服务器解析)或 IP 地址。

- 使用通配符指定的一系列机器

- 使用

*或?字符指定字符串匹配项。通配符不能用于 IP 地址;但是,如果反向 DNS 查找失败,则可能会意外起作用。当在完全限定域名中指定通配符时,点(.)不会包含在通配符中。例如:*.example.com包含one.example.com,但不包括include one.two.example.com。 - IP 网络

- 使用 a.b.c.d/z,其中 a.b.c.d 是网络,z 是子网掩码的位数(如 192.168.0.0/24)。另一种可接受的格式是 a.b.c.d/netmask,其中 a.b.c.d 是网络,netmask 是子网掩码(例如 192.168.100.8/255.255.255.0)。

- Netgroups

- 使用格式 @group-name ,其中 group-name 是 NIS netgroup 名称。

8.6.6. 启用通过 RDMA(NFSoRDMA) 的 NFS

- 安装 rdma 和 rdma-core 软件包。

/etc/rdma/rdma.conf文件包含默认设置XPRTRDMA_LOAD=yes的行,它请求rdma服务加载 NFSoRDMA 客户端 模块。 - 要启用自动载入 NFSoRDMA 服务器模块,请在

/etc/rdma/rdma.conf中的新行中添加SVCRDMA_LOAD=yes。RPCNFSDARGS="--rdma=20049"在/etc/sysconfig/nfs文件中指定 NFSoRDMA 服务侦听客户端的端口号。RFC 5667 指定服务器在通过 RDMA 提供 NFSv4 服务时必须侦听端口20049。 - 编辑

/etc/rdma/rdma.conf文件后重启nfs服务:#systemctl restart nfs请注意,在较早的内核版本中,编辑/etc/rdma/rdma.conf后需要重启系统才能使更改生效。

8.6.7. 配置只使用 NFSv4 的服务器

rpcbind 服务来侦听网络。

Requested NFS version or transport protocol is not supported.

过程 8.2. 配置只使用 NFSv4 的服务器

- 通过在

/etc/sysconfig/nfs配置文件中添加以下行来禁用 NFSv2、NFSv3 和 UDP:RPCNFSDARGS="-N 2 -N 3 -U"

- (可选)禁用对

RPCBIND、MOUNT和NSM协议调用的监听,这在仅使用 NFSv4 的情况下不需要。禁用这些选项的影响有:- 尝试使用 NFSv2 或 NFSv3 从服务器挂载共享的客户端变得无响应。

- NFS 服务器本身无法挂载 NFSv2 和 NFSv3 文件系统。

禁用这些选项:- 在

/etc/sysconfig/nfs文件中添加以下内容:RPCMOUNTDOPTS="-N 2 -N 3"

- 禁用相关服务:

#systemctl mask --now rpc-statd.service rpcbind.service rpcbind.socket

- 重启 NFS 服务器:

#systemctl restart nfs一旦启动或重启 NFS 服务器,这些改变就会生效。

验证仅 NFSv4 配置

netstat 实用程序验证您的 NFS 服务器是否在 NFSv4 模式中配置。

- 以下是仅使用 NFSv4 服务器上的

netstat输出示例;也禁用了对RPCBIND、MOUNT和NSM的监听。在这里,nfs是唯一侦听 NFS 服务:#netstat -ltu Active Internet connections (only servers) Proto Recv-Q Send-Q Local Address Foreign Address State tcp 0 0 0.0.0.0:nfs 0.0.0.0:* LISTEN tcp 0 0 0.0.0.0:ssh 0.0.0.0:* LISTEN tcp 0 0 localhost:smtp 0.0.0.0:* LISTEN tcp6 0 0 [::]:nfs [::]:* LISTEN tcp6 0 0 [::]:12432 [::]:* LISTEN tcp6 0 0 [::]:12434 [::]:* LISTEN tcp6 0 0 localhost:7092 [::]:* LISTEN tcp6 0 0 [::]:ssh [::]:* LISTEN udp 0 0 localhost:323 0.0.0.0:* udp 0 0 0.0.0.0:bootpc 0.0.0.0:* udp6 0 0 localhost:323 [::]:* - 相比之下,在配置只使用 NFSv4 的服务器前

netstat输出会包括sunrpc和mountd服务:#netstat -ltu Active Internet connections (only servers) Proto Recv-Q Send-Q Local Address Foreign Address State tcp 0 0 0.0.0.0:nfs 0.0.0.0:* LISTEN tcp 0 0 0.0.0.0:36069 0.0.0.0:* LISTEN tcp 0 0 0.0.0.0:52364 0.0.0.0:* LISTEN tcp 0 0 0.0.0.0:sunrpc 0.0.0.0:* LISTEN tcp 0 0 0.0.0.0:mountd 0.0.0.0:* LISTEN tcp 0 0 0.0.0.0:ssh 0.0.0.0:* LISTEN tcp 0 0 localhost:smtp 0.0.0.0:* LISTEN tcp6 0 0 [::]:34941 [::]:* LISTEN tcp6 0 0 [::]:nfs [::]:* LISTEN tcp6 0 0 [::]:sunrpc [::]:* LISTEN tcp6 0 0 [::]:mountd [::]:* LISTEN tcp6 0 0 [::]:12432 [::]:* LISTEN tcp6 0 0 [::]:56881 [::]:* LISTEN tcp6 0 0 [::]:12434 [::]:* LISTEN tcp6 0 0 localhost:7092 [::]:* LISTEN tcp6 0 0 [::]:ssh [::]:* LISTEN udp 0 0 localhost:323 0.0.0.0:* udp 0 0 0.0.0.0:37190 0.0.0.0:* udp 0 0 0.0.0.0:876 0.0.0.0:* udp 0 0 localhost:877 0.0.0.0:* udp 0 0 0.0.0.0:mountd 0.0.0.0:* udp 0 0 0.0.0.0:38588 0.0.0.0:* udp 0 0 0.0.0.0:nfs 0.0.0.0:* udp 0 0 0.0.0.0:bootpc 0.0.0.0:* udp 0 0 0.0.0.0:sunrpc 0.0.0.0:* udp6 0 0 localhost:323 [::]:* udp6 0 0 [::]:57683 [::]:* udp6 0 0 [::]:876 [::]:* udp6 0 0 [::]:mountd [::]:* udp6 0 0 [::]:40874 [::]:* udp6 0 0 [::]:nfs [::]:* udp6 0 0 [::]:sunrpc [::]:*

8.7. 保护 NFS

8.7.1. 具有 AUTH_SYS 和导出控制的 NFS 安全性

AUTH_SYS (也称为 AUTH_UNIX)执行此操作,它依赖于客户端来声明用户的 UID 和 GID。请注意,这意味着恶意或配置错误的客户端可能会很容易地出现这个错误,并允许用户访问他不应该访问的文件。

8.7.2. 带有 AUTH_GSS的 NFS 安全性

配置 Kerberos

过程 8.3. 为 IdM 配置 NFS 服务器和客户端以使用 RPCSEC_GSS

- 在 NFS 服务器端创建

nfs/hostname.domain@REALM主体。 - 在服务器和客户端端创建

host/hostname.domain@REALM主体。注意主机名 必须与 NFS 服务器主机名相同。 - 将对应的密钥添加到客户端和服务器的 keytab 中。

具体步骤请查看 Red Hat Enterprise Linux 7 Linux Domain Identity, Authentication, and Policy Guide 中的 Adding and Editing Service Entries and Keytabs and setting an Kerberos-aware NFS Server 部分。- 在服务器端,使用

sec=选项启用所需的安全类型。启用所有安全类型和非加密挂载:/export *(sec=sys:krb5:krb5i:krb5p)

与sec=选项一起使用的有效安全类型为:sys: 没有加密保护,默认krb5: authentication onlykrb5i: 完整性保护krb5p: 隐私保护

- 在客户端,将

sec=krb5(或sec=krb5i, 或sec=krb5p,具体取决于设置)添加到挂载选项:# mount -o sec=krb5 server:/export /mnt

有关如何配置 NFS 客户端的详情,请参考 Red Hat Enterprise Linux 7 Linux 域身份、身份验证和策略指南中的 设置 Kerberos 感知 NFS 客户端 部分。

其它资源

- 虽然红帽建议使用 IdM,但也支持 Active Directory (AD) Kerberos 服务器。详情请查看以下红帽知识库文章: 如何使用 SSSD 和 Active Directory 在 RHEL 7 中使用 Kerberos 身份验证设置 NFS。

- 如果您需要以 root 用户身份在 Kerberos 保护的 NFS 共享中写入文件,并对这些文件保留 root 所有权,请参阅 https://access.redhat.com/articles/4040141。请注意,我们不推荐进行此配置。

8.7.2.1. 使用 NFSv4 的 NFS 安全性

MOUNT 协议来挂载文件系统。MOUNT 协议存在安全风险,因为协议处理文件句柄的方式。

8.7.3. 文件权限

nobody。root squashing 由默认选项 root_squash 控制 ; 有关这个选项的详情请参考 第 8.6.1 节 “/etc/exports 配置文件”。如果可能的话,切勿禁用 root 压缩。

all_squash 选项。这个选项使访问导出的文件系统的每个用户都使用 nfsnobody 用户的用户 ID。

8.8. NFS 和 rpcbind

rpcbind 服务以便向后兼容的 NFSv3 实现。

rpcbind )的详情,请参考 第 8.6.7 节 “配置只使用 NFSv4 的服务器”。

8.8.1. NFS 和 rpcbind故障排除

# rpcinfo -p例 8.7. rpcinfo -p 命令输出

program vers proto port service

100021 1 udp 32774 nlockmgr

100021 3 udp 32774 nlockmgr

100021 4 udp 32774 nlockmgr

100021 1 tcp 34437 nlockmgr

100021 3 tcp 34437 nlockmgr

100021 4 tcp 34437 nlockmgr

100011 1 udp 819 rquotad

100011 2 udp 819 rquotad

100011 1 tcp 822 rquotad

100011 2 tcp 822 rquotad

100003 2 udp 2049 nfs

100003 3 udp 2049 nfs

100003 2 tcp 2049 nfs

100003 3 tcp 2049 nfs

100005 1 udp 836 mountd

100005 1 tcp 839 mountd

100005 2 udp 836 mountd

100005 2 tcp 839 mountd

100005 3 udp 836 mountd

100005 3 tcp 839 mountd8.9. pNFS

pNFS Flex 文件

挂载 pNFS 共享

- 要启用 pNFS 功能,使用 NFS 版本 4.1 或更高版本从启用了 pNFS 的服务器挂载共享:

#mount -t nfs -o v4.1 server:/remote-export /local-directory服务器启用 pNFS 后,在第一次挂载时会自动载入nfs_layout_nfsv41_files内核。输出中的挂载条目应包含minorversion=1。使用以下命令验证模块是否已加载:$ lsmod | grep nfs_layout_nfsv41_files - 要从支持 Flex Files 的服务器中挂载带有 Flex Files 功能的 NFS 共享,请使用 NFS 版本 4.2 或更高版本:

#mount -t nfs -o v4.2 server:/remote-export /local-directory验证nfs_layout_flexfiles模块是否已加载:$lsmod | grep nfs_layout_flexfiles

其它资源

8.10. 在 NFS 中启用 pNFS SCSI 布局

先决条件

- 客户端和服务器必须能够向同一个块设备发送 SCSI 命令。就是说块设备必须位于共享的 SCSI 总线中。

- 块设备必须包含 XFS 文件系统。

- SCSI 设备必须支持 SCSI Persistent Reservations,如 SCSI-3 Ppriary Commands 规格中所述。

8.10.1. pNFS SCSI 布局

客户端和服务器之间的操作

LAYOUTGET 操作。服务器会使用文件在 SCSI 设备中的位置进行响应。客户端可能需要执行 GETDEVICEINFO 的额外操作,以确定要使用哪个 SCSI 设备。如果这些操作正常工作,客户端可以直接向 SCSI 设备发出 I/O 请求,而不是向服务器发送 READ 和 WRITE 操作。

READ 和 WRITE 操作,而不是直接向 SCSI 设备发送 I/O 请求。

设备保留

8.10.2. 检查与 pNFS 兼容的 SCSI 设备

先决条件

- 安装 sg3_utils 软件包:

# yum install sg3_utils

过程 8.4. 检查与 pNFS 兼容的 SCSI 设备

- 在服务器和客户端中检查正确的 SCSI 设备支持:

# sg_persist --in --report-capabilities --verbose path-to-scsi-device

确保设置了 Persist Through Power Los Active (PTPL_A)位。例 8.8. 支持 pNFS SCSI 的 SCSI 设备

以下是支持 pNFS SCSI 的 SCSI 设备的sg_persist输出示例。PTPL_A位报告1。inquiry cdb: 12 00 00 00 24 00 Persistent Reservation In cmd: 5e 02 00 00 00 00 00 20 00 00 LIO-ORG block11 4.0 Peripheral device type: disk Report capabilities response: Compatible Reservation Handling(CRH): 1 Specify Initiator Ports Capable(SIP_C): 1 All Target Ports Capable(ATP_C): 1 Persist Through Power Loss Capable(PTPL_C): 1 Type Mask Valid(TMV): 1 Allow Commands: 1 Persist Through Power Loss Active(PTPL_A): 1 Support indicated in Type mask: Write Exclusive, all registrants: 1 Exclusive Access, registrants only: 1 Write Exclusive, registrants only: 1 Exclusive Access: 1 Write Exclusive: 1 Exclusive Access, all registrants: 1

其它资源

- sg_persist(8) man page

8.10.3. 在服务器中设置 pNFS SCSI

过程 8.5. 在服务器中设置 pNFS SCSI

- 在服务器中挂载在 SCSI 设备中创建的 XFS 文件系统。

- 将 NFS 服务器配置为导出 NFS 版本 4.1 或更高版本。在

/etc/nfs.conf文件的[nfsd]部分中设置以下选项:[nfsd] vers4.1=y

- 将 NFS 服务器配置为通过 NFS 导出 XFS 文件系统,使用

pnfs选项:例 8.9. /etc/exports 中的条目导出 pNFS SCSI

/etc/exports配置文件中的以下条目将挂载到/exported/directory/的文件系统导出到allowed.example.com客户端,来作为 pNFS SCSI 布局:/exported/directory allowed.example.com(pnfs)

其它资源

- 有关配置 NFS 服务器的详情请参考 第 8.6 节 “配置 NFS 服务器”。

8.10.4. 在客户端中设置 pNFS SCSI

先决条件

- NFS 服务器被配置为通过 pNFS SCSI 导出 XFS 文件系统。请参阅 第 8.10.3 节 “在服务器中设置 pNFS SCSI”。

过程 8.6. 在客户端中设置 pNFS SCSI

- 在客户端中使用 NFS 版本 4.1 或更高版本挂载导出的 XFS 文件系统:

# mount -t nfs -o nfsvers=4.1 host:/remote/export /local/directory

不要在没有 NFS 的情况下直接挂载 XFS 文件系统。

其它资源

- 有关挂载 NFS 共享的详情请参考 第 8.2 节 “配置 NFS 客户端”。

8.10.5. 在服务器中释放 pNFS SCSI 保留

先决条件

- 安装 sg3_utils 软件包:

# yum install sg3_utils

过程 8.7. 在服务器中释放 pNFS SCSI 保留

- 在服务器上查询现有保留:

# sg_persist --read-reservation path-to-scsi-device

例 8.10. 在 /dev/sda 上查询保留

# sg_persist --read-reservation /dev/sda LIO-ORG block_1 4.0 Peripheral device type: disk PR generation=0x8, Reservation follows: Key=0x100000000000000 scope: LU_SCOPE, type: Exclusive Access, registrants only - 删除服务器上的现有注册:

# sg_persist --out \ --release \ --param-rk=reservation-key \ --prout-type=6 \ path-to-scsi-device例 8.11. 删除 /dev/sda 上的保留

# sg_persist --out \ --release \ --param-rk=0x100000000000000 \ --prout-type=6 \ /dev/sda LIO-ORG block_1 4.0 Peripheral device type: disk

其它资源

- sg_persist(8) man page

8.10.6. 监控 pNFS SCSI 布局功能

先决条件

- 配置了 pNFS SCSI 客户端和服务器。

8.10.6.1. 从使用 nfsstat 的服务器检查 pNFS SCSI 操作

nfsstat 工具来监控服务器的 pNFS SCSI 操作。

过程 8.8. 从使用 nfsstat 的服务器检查 pNFS SCSI 操作

- 监控服务器中服务的操作:

# watch --differences \ "nfsstat --server | egrep --after-context=1 read\|write\|layout" Every 2.0s: nfsstat --server | egrep --after-context=1 read\|write\|layout putrootfh read readdir readlink remove rename 2 0% 0 0% 1 0% 0 0% 0 0% 0 0% -- setcltidconf verify write rellockowner bc_ctl bind_conn 0 0% 0 0% 0 0% 0 0% 0 0% 0 0% -- getdevlist layoutcommit layoutget layoutreturn secinfononam sequence 0 0% 29 1% 49 1% 5 0% 0 0% 2435 86% - 客户端和服务器在以下情况下使用 pNFS SCSI 操作:

layoutget、layoutreturn和layoutcommit计数器递增。这意味着服务器提供布局。- 服务器

读写

8.10.6.2. 使用 mountstats 从客户端检查 pNFS SCSI 操作

/proc/self/mountstats 文件来监控客户端的 pNFS SCSI 操作。

过程 8.9. 使用 mountstats 从客户端检查 pNFS SCSI 操作

- 列出每个挂载的操作计数器:

# cat /proc/self/mountstats \ | awk /scsi_lun_0/,/^$/ \ | egrep device\|READ\|WRITE\|LAYOUT device 192.168.122.73:/exports/scsi_lun_0 mounted on /mnt/rhel7/scsi_lun_0 with fstype nfs4 statvers=1.1 nfsv4: bm0=0xfdffbfff,bm1=0x40f9be3e,bm2=0x803,acl=0x3,sessions,pnfs=LAYOUT_SCSI READ: 0 0 0 0 0 0 0 0 WRITE: 0 0 0 0 0 0 0 0 READLINK: 0 0 0 0 0 0 0 0 READDIR: 0 0 0 0 0 0 0 0 LAYOUTGET: 49 49 0 11172 9604 2 19448 19454 LAYOUTCOMMIT: 28 28 0 7776 4808 0 24719 24722 LAYOUTRETURN: 0 0 0 0 0 0 0 0 LAYOUTSTATS: 0 0 0 0 0 0 0 0 - 在结果中:

LAYOUT统计指示客户端和服务器使用 pNFS SCSI 操作的请求。READ和WRITE统计指示客户端和服务器回退到 NFS 操作的请求。

8.11. NFS 参考

安装的文档

- man mount - 包含了全面查看 NFS 服务器和客户端配置的挂载选项。

- man fstab - 提供在启动时挂载文件系统的

/etc/fstab文件格式的详细信息。 - man nfs - 提供特定于 NFS 文件系统导出和挂载选项的详情。

- man exports - 显示导出 NFS 文件系统时

/etc/exports文件中使用的常见选项。

有用的网站

- http://linux-nfs.org - 开发人员查看项目状态更新的的当前站点。

- http://nfs.sourceforge.net/ - 开发人员的老家,里面仍然包含了很多有用的信息。

- http://www.citi.umich.edu/projects/nfsv4/linux/ - Linux 2.6 内核资源的 NFSv4。

- http://citeseer.ist.psu.edu/viewdoc/summary?doi=10.1.1.111.4086 - 关于 NFS 版本 4 协议的功能和加强的完美白皮书。

相关的图书

- Hal Stern、Mike Eisler 和 Ricardo labiaga 管理 NFS 和 NIS ;O'Reilly & Associates - 为许多不同的 NFS 导出和挂载选项提供了很好的参考指南。

- Brent Callaghan 的 NFS Illustrated; Addison-Wesley 出版公司 - 提供了 NFS 与其他网络文件系统的比较,并详细介绍了 NFS 通信是如何发生的。

第 9 章 服务器消息块(SMB)

cifs-utils 工具从远程服务器挂载 SMB 共享。

cifs。

9.1. 提供 SMB 共享

9.2. 挂载 SMB 共享

cifs.ko 文件系统模块提供对 SMB 协议的支持。但是,要挂载并使用 SMB 共享,还必须安装 cifs-utils 软件包:

# yum install cifs-utils- 挂载 SMB 和 CIFS 共享

- 在内核的密钥环中管理 NT Lan Manager (NTLM)凭据

- 在 SMB 和 CIFS 共享上的安全描述符中设置和显示访问控制列表(ACL)

9.2.1. 支持的 SMB 协议版本

cifs.ko 内核模块支持以下 SMB 协议版本:

- SMB 1

- SMB 2.0

- SMB 2.1

- SMB 3.0

9.2.1.1. UNIX 扩展支持

CAP_UNIX 功能位来提供 UNIX 扩展功能。cifs.ko 内核模块也支持这些扩展。但是,Samba 和内核模块仅支持 SMB 1 协议中的 UNIX 扩展。

- 将

/etc/samba/smb.conf文件中的[global]部分中的server min protocol选项设置为NT1。这是 Samba 服务器中的默认设置。 - 通过向 mount 命令提供

-o vers=1.0选项,使用 SMB 1 协议 挂载共享。例如:mount -t cifs -o vers=1.0,username=user_name //server_name/share_name /mnt/默认情况下,内核模块使用 SMB 2 或服务器支持的最高协议版本。将-o vers=1.0选项传给 mount 命令会强制内核模块使用 SMB 1 协议,该协议在使用 UNIX 扩展时是必需的。

# mount

...

//server/share on /mnt type cifs (...,unix,...)

unix 条目,则启用了 UNIX 扩展。

9.2.2. 手动挂载 SMB 共享

-t cifs 参数中使用 mount 工具:

# mount -t cifs -o username=user_name //server_name/share_name /mnt/ Password for user_name@//server_name/share_name: ********

例 9.1. 使用加密的 SMB 3.0 连接挂载共享

\\服务器\示例\ 共享作为 DOMAIN\Administrator 用户通过加密的 SMB 3.0 连接挂载到 /mnt/ 目录:

# mount -t cifs -o username=DOMAIN\Administrator,seal,vers=3.0 //server/example /mnt/ Password for user_name@//server_name/share_name: ********

9.2.3. 在系统引导时自动挂载 SMB 共享

/etc/fstab 文件中。例如:

//server_name/share_name /mnt cifs credentials=/root/smb.cred 0 0

/etc/fstab 文件的第四个字段中,指定挂载选项,如凭据文件的路径。详情请查看 第 9.2.6 节 “常用挂载选项” man page 中的 mount.cifs(8) 和 OPTIONS 部分。

# mount /mnt/9.2.4. 使用凭据文件对 SMB 共享进行身份验证

过程 9.1. 创建凭证文件

- 创建一个文件,如

~/smb.cred,并指定该文件的用户名、密码和域名:username=user_name password=password domain=domain_name

- 将权限设置为只允许所有者可以访问该文件:

#chown user_name ~/smb.cred#chmod 600 ~/smb.cred

credentials=file_name 挂载选项传给 mount 工具,或者在 /etc/fstab 文件中使用它来挂载共享,而无需提示输入用户名和密码。

9.2.5. 执行多用户 SMB 挂载

DOMAIN\example 用户,则共享上的所有操作都将以该用户的身份执行,无论哪个本地用户执行该操作。

multiuser 挂载选项允许您配置此场景。

multiuser,还必须将 sec=security_type 挂载选项设置为支持以非交互方式提供凭据的安全类型,如 krb5 或带有凭据文件的 ntlmssp 选项。请参阅 “以用户身份访问共享”一节。

root 用户使用 multiuser 选项以及对共享内容具有最少访问权限的帐户挂载共享。然后,常规用户可以使用 cifscreds 实用程序将其用户名和密码提供给当前会话的内核密钥环。如果用户访问挂载的共享的内容,则内核将使用内核密钥环中的凭据,而不是最初用来挂载共享的凭据。

使用 multiuser 选项挂载共享

multiuser 选项自动挂载共享:

过程 9.2. 使用 multiuser 选项创建 /etc/fstab 文件条目

- 在

/etc/fstab文件中为共享创建条目。例如://server_name/share_name /mnt cifs multiuser,sec=ntlmssp,credentials=/root/smb.cred 0 0 - 挂载共享:

#mount /mnt/

-o multiuser,sec=security_type 传递给 mount 命令手动挂载它。有关手动挂载 SMB 共享的详情,请参考 第 9.2.2 节 “手动挂载 SMB 共享”。

验证 SMB 共享是否使用 multiuser 选项挂载

multiuser 选项验证共享是否挂载:

# mount

...

//server_name/share_name on /mnt type cifs (sec=ntlmssp,multiuser,...)

以用户身份访问共享

multiuser 选项挂载 SMB 共享,用户可以向内核的密钥环提供其服务器凭证:

# cifscreds add -u SMB_user_name server_name

Password: ********

9.2.6. 常用挂载选项

- 如何与服务器建立连接。例如:连接到服务器时使用 SMB 协议版本。

- 如何将共享挂载到本地文件系统.例如,如果系统覆盖了远程文件和目录的权限,使多个本地用户能够访问服务器上的内容。

/etc/fstab 文件的第四个字段或 挂载 命令的 -o 参数中设置多个选项,请使用逗号分隔它们。例如,请参阅 过程 9.2, “使用 multiuser 选项创建 /etc/fstab 文件条目”。

表 9.1. 常用挂载选项

| 选项 | 描述 |

|---|---|

| credentials=file_name | 设置凭证文件的路径。请参阅 第 9.2.4 节 “使用凭据文件对 SMB 共享进行身份验证”。 |

| dir_mode=mode | 如果服务器不支持 CIFS UNIX 扩展,则设置目录模式。 |

| file_mode=mode | 如果服务器不支持 CIFS UNIX 扩展,则设置文件模式。 |

| password=password | 设置在 SMB 服务器中验证的密码。另外,也可使用 credentials 选项指定凭据文件。 |

| seal | 使用 SMB 3.0 或更高的协议版本启用对连接的加密支持。因此,使用 seal 和 vers 挂载选项来设置成 3.0 或更高版本。请参阅 例 9.1 “使用加密的 SMB 3.0 连接挂载共享”。 |

| sec=security_mode |

设置安全模式,如 ntlmsspi,来启用 NTLMv2 密码哈希和已启用的数据包签名。有关支持的值列表,请查看 mount.cifs(8) man page 中的选项描述。

如果服务器不支持 ntlmv2 安全模式,则使用

sec=ntlmssp,这是默认值。出于安全考虑,请不要使用不安全的 ntlm 安全模式。

|

| username=user_name | 设置在 SMB 服务器中验证的用户名。另外,也可使用 credentials 选项指定凭据文件。 |

| vers=SMB_protocol_version | 设定用于与服务器通信的 SMB 协议版本。 |

第 10 章 FS-Cache

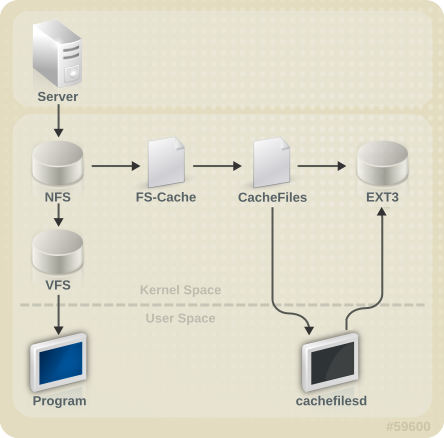

图 10.1. FS-Cache 概述

[D]

10.1. 性能保证

10.2. 设置缓存

/etc/cachefilesd.conf 文件控制 cachefile 如何提供缓存服务。

$ dir /path/to/cache/etc/cachefilesd.conf 中被设置为 /var/cache/fscache,如下所示:

$ dir /var/cache/fscache

/var/cache/fscache 相同:

#semanage fcontext -a -e /var/cache/fscache /path/to/cache#restorecon -Rv /path/to/cache

#semanage permissive -a cachefilesd_t#semanage permissive -a cachefiles_kernel_t

/)作为主机文件系统,但对于桌面计算机而言,更谨慎地挂载专门用于缓存的磁盘分区。

- ext3(启用了扩展属性)

- ext4

- Btrfs

- XFS

# tune2fs -o user_xattr /dev/device

# mount /dev/device /path/to/cache -o user_xattrcachefilesd 服务:

# systemctl start cachefilesd

# systemctl enable cachefilesd10.3. 在 NFS 中使用缓存

# mount nfs-share:/ /mount/point -o fsc10.3.1. 缓存共享

- 第 1 级:服务器详情

- 第 2 级:一些挂载选项;安全类型;FSID;uniquifier

- 第 3 级:文件处理

- 第 4 级:文件中的页号

例 10.1. 缓存共享

/home/fred 和 /home/jim 可能会共享超级块,因为它们具有相同的选项,特别是当它们来自 NFS 服务器(home0)上的相同卷/分区时。现在,考虑接下来的两个挂载命令:

/home/fred 和 /home/jim 不会共享超级块,因为它们具有不同的网络访问参数,这些参数是第 2 级密钥的一部分。以下的挂载序列也是如此:

/home/fred1 和 /home/fred2)将缓存 两次。

home0:/disk0/fred 和 home0:/disk0/jim 的第 2 级密钥。要解决这个问题,请在至少一个挂载上添加一个 唯一标识符,即 fsc=unique-identifier。例如:

/home/jim 缓存中使用的第 2 级键中。

10.3.2. 使用 NFS 的缓存限制

- 为直接 I/O 打开共享文件系统的文件将自动绕过缓存。这是因为这种访问类型必须与服务器直接进行。

- 打开共享文件系统的文件进行写入不适用于 NFS 版本 2 和 3。这些版本的协议无法为客户端提供足够的一致性管理信息,来检测另一客户端对同一文件的并发写入。

- 从共享文件系统打开一个文件直接 I/O 或写入清除文件缓存的副本。FS-Cache 不会再次缓存文件,直到它不再为直接 I/O 或写操作而打开。

- 另外,FS-Cache 的这个发行版本只缓存常规 NFS 文件。FS-Cache 不会 缓存目录、符号链接、设备文件、FIFO 和套接字。

10.4. 设置缓存剔除限制

/etc/cachefilesd.conf 中的设置控制六个限制:

N 的默认值如下:

- brun/frun - 10%

- bcull/fcull - 7%

- bstop/fstop - 3%

- 0 PROFILE bstop < bcull < brun < 100

- 0 PROFILE fstop < fcull < frun < 100

10.5. 统计信息

# cat /proc/fs/fscache/stats/usr/share/doc/kernel-doc-version/Documentation/filesystems/caching/fscache.txt

10.6. FS-Cache 参考

/usr/share/doc/cachefilesd-version-number/README/usr/share/man/man5/cachefilesd.conf.5.gz/usr/share/man/man8/cachefilesd.8.gz

/usr/share/doc/kernel-doc-version/Documentation/filesystems/caching/fscache.txt

部分 II. 存储管理

第 11 章 安装过程中的存储注意事项

11.1. 特殊注意事项

/home、/opt、/usr/local 的单独分区

/home、/opt 和 /usr/local 放在单独的设备中。这可让您重新格式化包含操作系统的设备或文件系统,同时保留您的用户和应用程序数据。

IBM System Z 上的 DASD 和 zFCP 设备

DASD= 参数。

FCP_x= 行允许您为安装程序指定此信息。

使用 LUKS 加密块设备

过时的 BIOS RAID 元数据

# dmraid -r -E /device/iSCSI 检测和配置

FCoE 检测和配置

DASD

启用了 DIF/DIX 的块设备

第 12 章 文件系统检查

/etc/fstab 中列出的每个文件系统上运行文件系统检查。对于日志记录文件系统,这通常是一个非常短的操作,因为即使崩溃,文件系统的元数据日志也会确保一致性。

/etc/fstab 中的第六个字段设置为 0,可以在引导时禁用文件系统检查。12.1. fsck 的最佳实践

- 空运行

- 大多数文件系统检查程序都有一个操作模式,用于检查但不修复文件系统。在这个模式中,检查程序会输出它发现的任何错误以及它所执行的操作,而无需实际修改文件系统。注意稍后一致性检查阶段可能会打印额外的错误,因为在修复模式下运行时,它会发现可能在早期阶段已经修复了的不一致问题。

- 首先对文件系统镜像进行操作

- 大多数文件系统都支持创建 元数据镜像,这是仅包含元数据的文件系统的稀疏副本。由于文件系统检查程序仅在元数据上运行,因此此类镜像可用于对实际文件系统修复执行空运行,以评估实际要进行的更改。如果更改可以接受,则可以对文件系统本身进行修复。注意严重损坏的文件系统可能会导致元数据镜像创建出现问题。

- 保存文件系统镜像以进行支持调查

- 如果因为软件错误导致损坏,则预修复文件系统元数据镜像通常有助于支持调查。修复前镜像中存在的损坏模式可能有助于根本原因的分析。

- 仅在卸载的文件系统上运行

- 文件系统修复必须只在卸载的文件系统上运行。该工具必须具有对文件系统的唯一访问权限,或者可能导致进一步的损坏。大多数文件系统工具在修复模式下强制实施这个要求,虽然有些文件系统只支持在挂载的文件系统中只检查模式。如果在挂载的文件系统上运行只检查模式,则可能发现在卸载的文件系统上运行时未找到的错误。

- 磁盘错误

- 文件系统检查工具不能修复硬件问题。如果修复操作成功,文件系统必须是完全可读写的。如果文件系统因为硬件错误而损坏,则必须首先将文件系统移至良好磁盘,例如使用 dd (8) 工具。

12.2. fsck 的文件系统特定信息

12.2.1. ext2、ext3 和 ext4

e2fsck 二进制文件来执行文件系统检查和修复。文件名 fsck.ext2、 fsck.ext3 和 fsck.ext4 是同一二进制文件的硬链接。这些二进制文件在引导时自动运行,其行为因正在检查的文件系统和文件系统的状态而异。

- -n

- 无修改模式.仅检查操作.

- -b superblock

- 如果主块被损坏,请指定备用的 suprerblock 的块数。

- -f

- 如果超级块没有记录的错误,也强制进行全面检查。

- -j journal-dev

- 指定外部日志设备(若有的话)。

- -p

- 自动修复或"复制"文件系统,无需用户输入。

- -y

- 假设所有问题的答案都为"是"。

- Inode、块和大小检查.

- 目录结构检查。

- 目录连接性检查。

- 参考计数检查。

- 组摘要信息检查。

12.2.2. XFS

fsck.xfs 二进制文件,但这仅用于满足在启动时查找 fsck 的 initscripts。文件系统 二进制文件。fsck.xfs 立即退出,退出代码为 0。

- -n

- 无修改模式。仅检查操作.

- -L

- 将元数据日志归零。仅当无法通过 mount 重新执行日志时才使用。

- -m maxmem

- 将运行期间使用的内存限制为 maxmem MB。可以指定 0 来粗略估算所需的最小内存。

- -l logdev

- 如果存在,指定外部日志设备。

- inode 和 inode 块映射(寻址)检查.

- inode 分配映射检查。

- inode 大小检查。

- 目录检查。

- 路径名称检查。

- 链接数检查。

- 空闲映射检查。

- 超级块检查。

12.2.3. Btrfs

- 扩展检查。

- 文件系统 root 检查。

- 根参考计数检查。

第 13 章 分区

- 查看现有的分区表。

- 更改现有分区的大小。

- 从可用空间或其他硬盘添加分区。

# parted /dev/sda使用中的设备处理分区

修改分区表

# partx --update --nr partition-number disk

- 如果磁盘中的分区无法卸载,则以救援模式引导系统,例如在系统磁盘的情况下。

- 当提示挂载文件系统时,请选择 Skip。

表 13.1. parted 命令

| 命令 | 描述 |

|---|---|

| 帮助 | 显示可用命令列表 |

| mklabel label | 为分区表创建磁盘标签 |

| mkpart part-type [fs-type] start-mb end-mb | 在不创建新文件系统的情况下创建分区 |

| name minor-num name | 只为 Mac 和 PC98 磁盘标签命名分区 |

| 显示分区表 | |

| quit | 退出 parted |

| rescue start-mb end-mb | 抢救丢失的分区(从 Start-mb 到 end-mb) |

| rm minor-num | 删除分区 |

| 选择设备 | 选择要配置的其他设备 |

| set minor-num flag state | 在分区中设置标志 ; state 为 on 或 off |

| toggle [NUMBER [FLAG] | 切换分区 NUMBER上的 FLAG 状态 |

| unit UNIT | 将默认单位设置为 UNIT |

13.1. 查看分区表

- 启动 parted。

- 使用以下命令查看分区表:

(parted)print

例 13.1. 分区表

Model: ATA ST3160812AS (scsi) Disk /dev/sda: 160GB Sector size (logical/physical): 512B/512B Partition Table: msdos Number Start End Size Type File system Flags 1 32.3kB 107MB 107MB primary ext3 boot 2 107MB 105GB 105GB primary ext3 3 105GB 107GB 2147MB primary linux-swap 4 107GB 160GB 52.9GB extended root 5 107GB 133GB 26.2GB logical ext3 6 133GB 133GB 107MB logical ext3 7 133GB 160GB 26.6GB logical lvm

- 模型:ATA ST3160812AS (scsi) :解释磁盘类型、制造商、型号号和接口。

- 磁盘 /dev/sda: 160GB :显示块设备和存储容量的文件路径。

- partition Table: msdos: 显示磁盘标签类型。

- 在分区表中,

Number是分区号。例如,次号 1 的分区对应于/dev/sda1。Start和End值以 MB 为单位。有效的Types是 metadata, free, primary, extended, or logical。File system是文件系统类型。Flags 列中列出了为分区设置的标志。可用的标志有 boot、root、swap、hidden、raid、lvm 或 lba。

File system 可以是以下任意一种:

- ext2

- ext3

- fat16

- fat32

- hfs

- jfs

- linux-swap

- ntfs

- reiserfs

- hp-ufs

- sun-ufs

- xfs

File system 没有显示值,这意味着其文件系统类型未知。

13.2. 创建分区

过程 13.1. 创建分区

- 在创建分区前,引导进入救援模式,或者卸载该设备中的任何分区,并关闭该设备上的任何交换空间。

- 启动 parted :

# parted /dev/sda使用您要在其上创建分区的设备名称替换 /dev/sda。 - 查看当前的分区表来确定是否有足够空闲空间:

(parted)print如果没有足够的可用空间,您可以调整现有分区的大小。如需更多信息,请参阅 第 13.5 节 “使用 fdisk 重新定义分区大小”。 - 创建分区:

(parted)mkpart part-type name fs-type start end根据您的要求,将 part-type 替换为 primary、logical 或 extended。使用分区名称替换 name ;GPT 分区表需要 name。使用 btrfs、ext2、ext3、ext4、fat16、fat32、hfs、hfs+、linux-swap、ntfs、reiserfs 或 xfs; fs-type 之一替换 fs-type。根据您的要求,将 start 以 MB 为单位表示。例如,要在硬盘上创建从 1024MB 到 2048 MB 的 ext3 文件系统的主分区,请输入以下命令:(parted)mkpart primary 1024 2048注意如果您使用 mkpartfs 命令,文件系统会在分区创建后创建。但是 parted 不支持创建 ext3 文件系统。因此,如果要创建 ext3 文件系统,请使用 mkpart 并使用 mkfs 命令创建文件系统,如稍后所述。按 Enter 键后,这些更改就会生效,因此请在执行前检查命令。 - 使用以下命令,查看分区表以确认创建的分区位于分区表中,并具有正确的分区类型、文件系统类型和大小:

(parted)print还请记住新分区的次要号,以便您可以在其上面标记任何文件系统。 - 退出 parted shell:

(parted)quit - 在 parted 关闭后使用以下命令,以确保内核识别新分区:

#cat /proc/partitions

13.2.1. 格式化和标记分区

过程 13.2. 格式化和标记分区

- 分区没有文件系统。要创建

ext4文件系统,请使用:#mkfs.ext4 /dev/sda6警告格式化分区会永久销毁分区上当前存在的任何数据。 - 标记分区中的文件系统。例如:如果新分区中的文件系统是

/dev/sda6,而您想要将其标记为Work,请使用:#e2label /dev/sda6 "Work"默认情况下,安装程序使用分区挂载点作为标签,以确保标签是唯一的。您可以使用您想要的任何标签。 - 以 root 身份创建挂载点(如

/work)。

13.2.2. 将分区添加到 /etc/fstab

- 以 root 用户身份,编辑

/etc/fstab文件,以使用分区的 UUID 包含新分区。使用命令 blkid -o list 获取分区 UUID 的完整列表,或使用 blkid 设备 获取单个设备详情。在/etc/fstab中:- 第一列应当包含

UUID=,后跟文件系统的 UUID。 - 第二列应包含新分区的挂载点。

- 第三列应为文件系统类型:例如

ext4或swap。 - 第四列列出了文件系统的挂载选项。此处的单词

defaults表示分区在引导时使用默认选项挂载。 - 第五个字段和第六个字段指定 backup 和 check 选项。非 root 分区的值示例为

0 2。

- 重新生成挂载单元以便您的系统注册新配置:

#systemctl daemon-reload - 尝试挂载文件系统来验证配置是否正常工作:

# mount /work

其它信息

- 如果您需要有关

/etc/fstab格式的更多信息,请参阅 fstab(5) man page。

13.3. 删除分区

过程 13.3. 删除分区

- 在删除分区前,请执行以下操作之一:

- 引导至救援模式,或者

- 卸载该设备中的任何分区,并关闭该设备上的任何交换空间。

- 启动

parted工具:# parted device使用删除分区的设备替换 device :例如/dev/sda。 - 查看当前的分区表以确定要删除的分区的次号:

(parted) print - 使用命令 rm 删除分区。例如:要删除次要号为 3 的分区:

(parted) rm 3按 Enter 键后,这些更改就会生效,因此请在提交前检查命令。 - 删除分区后,使用 print 命令确认它已从分区表中删除:

(parted) print - 从

partedshell 退出:(parted) quit - 检查

/proc/partitions文件的内容,以确保内核知道分区已被删除:# cat /proc/partitions - 从

/etc/fstab文件中删除分区。找到声明删除的分区的行,并将其从文件中删除。 - 重新生成挂载单元,以便您的系统注册新的

/etc/fstab配置:#systemctl daemon-reload

13.4. 设置分区类型

systemd-gpt-auto-generator,它使用分区类型来自动识别和挂载设备。

fdisk 工具,并使用 t 命令设置分区类型。以下示例演示了如何将第一个分区的分区类型改为 0x83,在 Linux 中默认:

#fdisk /dev/sdc Command (m for help): t Selected partition1Partition type (type L to list all types):83Changed type of partition 'Linux LVM' to 'Linux'.

parted 工具尝试将分区类型映射到"flags" (对最终用户来说并不方便)来提供一些分区类型控制。parted 工具只能处理某些分区类型,如 LVM 或 RAID。例如,要使用 parted 从第一个分区中删除 lvm 标志,请使用:

# parted /dev/sdc 'set 1 lvm off'

13.5. 使用 fdisk 重新定义分区大小

fdisk 实用程序允许您创建和操作 GPT、R MBR、SGI 和 BSD 分区表。建议在带有 GUID 分区表(GPT)的磁盘上,建议使用 parted 工具,因为 fdisk GPT 支持处于实验性阶段。

fdisk 更改分区大小的唯一方法是通过删除和重新创建分区。

过程 13.4. 调整分区大小

fdisk 调整分区大小:

- 卸载该设备:

#umount /dev/vda - 运行 fdisk disk_name。例如:

#fdisk /dev/vda Welcome to fdisk (util-linux 2.23.2). Changes will remain in memory only, until you decide to write them. Be careful before using the write command. Command (m for help): - 使用

p选项确定要删除的分区的行号。Command (m for help): p Disk /dev/vda: 16.1 GB, 16106127360 bytes, 31457280 sectors Units = sectors of 1 * 512 = 512 bytes Sector size (logical/physical): 512 bytes / 512 bytes I/O size (minimum/optimal): 512 bytes / 512 bytes Disk label type: dos Disk identifier: 0x0006d09a Device Boot Start End Blocks Id System /dev/vda1 * 2048 1026047 512000 83 Linux /dev/vda2 1026048 31457279 15215616 8e Linux LVM

- 使用 d 选项删除分区。如果有多个分区可用,fdisk 会提示您提供要删除的多个分区:

Command (m for help): d Partition number (1,2, default 2): 2 Partition 2 is deleted

- 使用

n选项创建分区并按照提示进行操作。允许足够空间以供将来重新定义大小。fdisk 默认行为(按Enter)是使用设备上的所有空间。您可以根据扇区指定分区的结束,或使用 + <size> <suffix> 指定人类可读的大小,如 +500M 或 +10G。如果您不想使用所有可用空间,红帽建议使用人类可读的大小规格,因为 fdisk 将分区的末尾与物理扇区一致。如果您通过提供准确数字(扇区)来指定大小,fdisk 不会对齐分区的末尾。Command (m for help): n Partition type: p primary (1 primary, 0 extended, 3 free) e extended Select (default p): *Enter* Using default response p Partition number (2-4, default 2): *Enter* First sector (1026048-31457279, default 1026048): *Enter* Using default value 1026048 Last sector, +sectors or +size{K,M,G} (1026048-31457279, default 31457279): +500M Partition 2 of type Linux and of size 500 MiB is set - 将分区类型设置为 LVM:

Command (m for help): t Partition number (1,2, default 2): *Enter* Hex code (type L to list all codes): 8e Changed type of partition 'Linux' to 'Linux LVM'

- 当您确定更改正确时,使用 w 选项写入更改,因为错误可能会导致所选分区不稳定。

- 在设备上运行 e2fsck 来检查一致性:

#e2fsck /dev/vda e2fsck 1.41.12 (17-May-2010) Pass 1:Checking inodes, blocks, and sizes Pass 2:Checking directory structure Pass 3:Checking directory connectivity Pass 4:Checking reference counts Pass 5:Checking group summary information ext4-1:11/131072 files (0.0% non-contiguous),27050/524128 blocks - 挂载该设备:

#mount /dev/vda

第 14 章 使用 Snapper 创建和维护快照

14.1. 创建 Initial Snapper 配置

过程 14.1. 创建 Snapper 配置文件

- 创建或选择:

- 一个精简配置的逻辑卷,它有一个红帽支持的文件系统,或者

- Btrfs 子卷。

- 挂载文件系统。

- 创建定义此卷的配置文件。对于 LVM2:

#snapper -c config_name create-config -f "lvm(fs_type)" /mount-point例如,要使用 ext4 文件系统(挂载于 /lvm_mount)在 LVM2 子卷上创建一个名为 lvm_config 的配置文件,请使用:#snapper -c lvm_config create-config -f "lvm(ext4)" /lvm_mount对于 Btrfs:#snapper -c config_name create-config -f btrfs /mount-point- -c config_name 选项指定配置文件的名称。

- create-config 告知 snapper 创建配置文件。

- f file_system 告知 snapper 要使用的文件系统;如果忽略了 snapper,则尝试检测文件系统。

- /mount-point 是挂载子卷或精简配置的 LVM2 文件系统的位置。

或者,要在挂载到/btrfs_mount的 Btrfs 子卷上创建一个名为btrfs_config的配置文件,请使用:#snapper -c btrfs_config create-config -f btrfs /btrfs_mount

/etc/snapper/configs/ 目录中。

14.2. 创建 Snapper 快照

- pre Snapshot

- pre 快照充当后快照的原始卷。这两个操作都紧密关联,旨在跟踪两个点之间的文件系统修改。必须在创建快照前创建预快照。

- 后快照

- post 快照充当预快照的端点。组合 pre 和 post 快照定义了要比较的范围。默认情况下,每个新 snapper 卷都配置为在成功创建相关后创建快照后创建后台比较。

- 单个快照

- 单个快照是在特定时间创建的独立快照。它们可用于跟踪修改时间表,并具有以后返回的一般点。

14.2.1. 创建 Pre 和 Post Snapshot Pair

14.2.1.1. 使用 Snapper 创建 Pre Snapshot

# snapper -c config_name create -t prepre、post 或 single。

lvm_config 配置文件创建预快照,如 第 14.1 节 “创建 Initial Snapper 配置” 中创建,请使用:

# snapper -c SnapperExample create -t pre -p

1

-p 选项打印创建快照的数量,并是可选的。

14.2.1.2. 使用 Snapper 创建 Post Snapshot

过程 14.2. 创建后快照

- 确定预快照的数量:

#snapper -c config_name list例如,要显示使用配置文件lvm_config创建的快照列表,请使用:#snapper -c lvm_config list Type | # | Pre # | Date | User | Cleanup | Description | Userdata -------+---+-------+-------------------+------+----------+-------------+--------- single | 0 | | | root | | current | pre | 1 | | Mon 06<...> | root | | |此输出显示预快照为数字 1。 - 创建链接到之前创建的预快照的后快照:

#snapper -c config_file create -t post --pre-num pre_snapshot_number- t post 选项指定创建快照类型的创建。

- --pre-num 选项指定对应的 pre snapshot。

例如,要使用lvm_config配置文件创建后快照并链接到预快照号 1,请使用:#snapper -c lvm_config create -t post --pre-num 1 -p 2-p选项打印创建快照的数量,并是可选的。 - 现在创建并配对了 pre 和 post 快照 1 和 2。使用 list 命令验证:

#snapper -c lvm_config list Type | # | Pre # | Date | User | Cleanup | Description | Userdata -------+---+-------+-------------------+------+----------+-------------+--------- single | 0 | | | root | | current | pre | 1 | | Mon 06<...> | root | | | post | 2 | 1 | Mon 06<...> | root | | |

14.2.1.3. 在 Pre 和 Post Snapshots 中嵌套命令

- 运行 snapper create pre snapshot 命令。

- 运行命令或命令列表,以对文件系统内容有可能的影响。

- 运行 snapper create post snapshot 命令。

过程 14.3. 在 Pre 和 Post Snapshots 中嵌套命令

- 在预快照和后快照中嵌套命令: