Red Hat Training

A Red Hat training course is available for Red Hat Enterprise Linux

逻辑卷管理器管理

Red Hat Enterprise Linux 7

配置和管理 LVM 逻辑卷

摘要

本书描述了 LVM 逻辑卷管理器,包括在集群环境中运行 LVM 的信息。

第 1 章 LVM 逻辑卷管理器

本章提供了自 Red Hat Enterprise Linux 7 初始发行版以来 LVM 逻辑卷管理器的新功能。本章还提供了逻辑卷管理器(LVM)组件的高级概述。

1.1. 新的和更改的功能

这部分列出了自 Red Hat Enterprise Linux 7 初始发行版以来 LVM 逻辑卷管理器的新功能。

1.1.1. Red Hat Enterprise Linux 7.1 的新功能和更改的功能

Red Hat Enterprise Linux 7.1 包含以下文档及功能的更新和更改:

- 对精简配置卷和精简配置快照的文档已进行了澄清。lvmthin(7) man page 中提供了有关 LVM 精简配置的附加信息。有关精简配置逻辑卷的常规信息,请参考 第 2.3.4 节 “精简配置的逻辑卷(精简卷)”。有关精简配置快照卷的详情,请参考 第 2.3.6 节 “精简配置的快照卷”。

- 这个手册现在在 第 B.2 节 “lvmconfig 命令” 中记录了 lvm dumpconfig 命令。请注意,在 Red Hat Enterprise Linux 7.2 版本中,这个命令被重命名为 lvmconfig,虽然旧格式仍可以正常工作。

- 这个手册现在在 第 B.3 节 “LVM 配置集” 中记录了 LVM 配置文件。

- 这个手册现在在 第 3.6 节 “使用 lvm 命令显示 LVM 信息” 中记录了 lvm 命令。

- 在 Red Hat Enterprise Linux 7.1 版本中,您可以使用 lvcreate 和 lvchange 命令的 -k 和 -K 选项控制精简池快照的激活,如 第 4.4.20 节 “控制逻辑卷激活” 所述。

- 这个手册记录了 vgimport 命令的

--force参数。这可让您导入缺少物理卷的卷组,然后运行 vgreduce --removemissing 命令。有关 vgimport 命令的详情,请参考 第 4.3.15 节 “将卷组移动到另一个系统”。 - 这个手册记录了 vgreduce 命令的

--mirrorsonly参数。这可让您仅从发生故障的物理卷中删除作为镜像的逻辑卷。有关使用这个选项的详情,请参考 第 4.3.15 节 “将卷组移动到另一个系统”。

此外,整个文档中也进行了小的技术修正和澄清。

1.1.2. Red Hat Enterprise Linux 7.2 的新功能和改变的功能

Red Hat Enterprise Linux 7.2 包含以下文档和功能的更新更改:

- 本文档提供了在 第 4.4.8 节 “创建 LVM 缓存逻辑卷” 中创建缓存逻辑卷的基本流程。

- 本文档的故障排除章节包含新的一章 第 6.7 节 “为多路径设备重复 PV Warning”。

- 从 Red Hat Enterprise Linux 7.2 发行版本中,lvm dumpconfig 命令被重命名为 lvmconfig,虽然旧格式仍可以正常工作。这一变化体现在本文档中。

此外,整个文档中也进行了小的技术修正和澄清。

1.1.3. Red Hat Enterprise Linux 7.3 的新功能和改变的功能

Red Hat Enterprise Linux 7.3 包含以下文档和功能的更新和更改。

- LVM 支持 RAID0 片段类型。RAID0 以条带大小的单位在多个数据子卷间分布逻辑卷数据。有关创建 RAID0 卷的详情,请参考 第 4.4.3.1 节 “创建 RAID0 卷(Red Hat Enterprise Linux 7.3 及更新版本)”。

- 您可以使用 lvm fullreport 命令一次报告物理卷、卷组、逻辑卷、物理卷片段和逻辑卷片段的信息。有关这个命令及其功能的详情,请查看 lvm-fullreport(8)手册页。

- LVM 支持日志报告,其中包含操作、消息和每个对象状态的日志,以及在 LVM 命令执行过程中收集的完整对象识别。有关 LVM 日志报告的示例,请参考 第 4.8.6 节 “命令报告(Red Hat Enterprise Linux 7.3 及更新的版本)”。有关 LVM 日志报告的详情,请查看 lvmreport(7)手册页。

- 您可以使用 LVM display 命令的

--reportformat选项以 JSON 格式显示输出。有关以 JSON 格式显示输出的示例,请参阅 第 4.8.5 节 “JSON 格式输出(Red Hat Enterprise Linux 7.3 及更新的版本)”。 - 现在,您可以通过在

lvm.conf配置文件中启用record_lvs_history元数据选项将系统配置为跟踪已删除的精简快照和精简逻辑卷。这可让您显示完整的精简快照依赖链,其中包括已经从原始依赖链中删除的逻辑卷和已变为 historical 的逻辑卷。有关历史逻辑卷的详情,请参考 第 4.4.21 节 “跟踪并显示历史逻辑卷(Red Hat Enterprise Linux 7.3 及更高版本)”。

此外,整个文档中也进行了小的技术修正和澄清。

1.1.4. Red Hat Enterprise Linux 7.4 的新功能和改变的功能

Red Hat Enterprise Linux 7.4 包括以下文档和功能的更新及更改:

- Red Hat Enterprise Linux 7.4 提供对 RAID 接管和 RAID 重塑的支持。有关这些功能的概述,请参阅 第 4.4.3.12 节 “RAID 接管(Red Hat Enterprise Linux 7.4 及更新的版本)” 和 第 4.4.3.13 节 “重塑 RAID 逻辑卷(Red Hat Enterprise Linux 7.4 及更新版本)”。

1.2. 逻辑卷

卷管理会在物理存储上创建一个提取层,以便您创建逻辑存储卷。这比直接使用物理存储的方式具有更大的灵活性。有了逻辑卷,就不会对物理磁盘大小进行限制。此外,硬件存储配置在软件中是隐藏的,因此可以在不停止应用程序或卸载文件系统的情况下调整大小和移动。这可降低操作成本。

与直接使用物理存储相比,逻辑卷具有以下优势:

- 灵活的容量当使用逻辑卷时,文件系统可在多个磁盘间扩展,您可以将磁盘和分区集合成一个逻辑卷。

- 重新调整存储池的大小您可以使用简单的软件命令扩展逻辑卷或减小逻辑卷的大小,而无需重新格式化和重新分区底层的磁盘设备。

- 在线数据重新定位部署更新、更快或者更弹性的存储子系统,可以在系统活跃时移动数据。在磁盘处于使用状态时可以重新分配磁盘。例如,您可以在删除热插拔磁盘前将其清空。

- 方便设备命名可在用户定义的和自定义命名的组中管理逻辑存储卷。

- 磁盘条带您可以创建一个在两个或者多个磁盘间条带分布数据的逻辑卷。这可显著提高吞吐量。

- 镜像卷逻辑卷为您提供了方便配置数据镜像的方法。

- 卷快照使用逻辑卷,您可以对一致性备份制作设备快照,或测试更改的效果,而不影响实际的数据。

本文档的其余部分描述了 LVM 中的这些功能的实现。

1.3. LVM 架构概述

注意

LVM2 与 LVM1 向后兼容,但快照和集群支持除外。您可以使用 vgconvert 命令将卷组从 LVM1 格式转换为 LVM2 格式。有关转换 LVM 元数据格式的详情,请参考 vgconvert(8)手册页。

LVM 逻辑卷的基本物理存储单元是块设备,比如一个分区或者整个磁盘。将这个设备初始化为 LVM 物理卷(PV)。

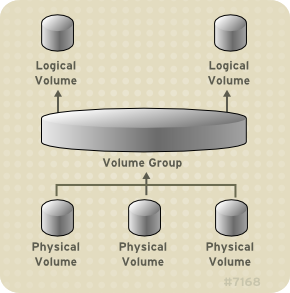

要创建 LVM 逻辑卷,可将物理卷合并到 卷组(VG)中。这会创建一个磁盘空间池,用于分配 LVM 逻辑卷(LV)。这个过程和将磁盘分区的过程类似。逻辑卷被文件系统和应用程序(如数据库)使用。

图 1.1 “LVM 逻辑卷组件” 显示简单 LVM 逻辑卷的组件:

图 1.1. LVM 逻辑卷组件

[D]

有关 LVM 逻辑卷组件的详情,请参考 第 2 章 LVM 组件。

1.4. 红帽高可用性集群中的 LVM 逻辑卷

红帽高可用性附加组件以两个不同的集群配置为 LVM 卷提供支持:

- 主动/被动故障转移配置中的高可用性 LVM 卷(HA-LVM),其中在任何时间点上只能有一个集群的节点可以访问存储。

- 在主动/主动配置中使用集群逻辑卷(CLVM)扩展的 LVM 卷,其中集群中有多个节点需要同时访问存储。CLVM 是弹性存储附加组件的一部分。

1.4.1. 选择 CLVM 或 HA-LVM

何时应使用 CLVM 或 HA-LVM,应根据所部署的应用程序或服务的需求。

- 如果集群的多个节点需要同时对主动/主动系统中的 LVM 卷进行读写访问,则必须使用 CLVMD。CLVMD 提供了一个系统,用于在集群的节点之间并行协调和更改 LVM 卷。CLVMD 的集群锁定服务对 LVM 元数据提供了保护,因为集群的不同节点与卷进行交互,并更改它们的布局。这种保护取决于问题正确配置卷组,包括在

lvm.conf文件中将locking_type设置为 3,并在任何由 CLVMD 管理的卷组上设置集群标志,并在多个集群节点上同时激活。 - 如果高可用性集群被配置为以主动/被动方式管理共享资源,且每次只有一个成员需要访问给定 LVM 卷,那么您可以使用没有 CLVMD 集群锁定服务的 HA-LVM。

因为大多数应用程序没有为与其他实例同时运行而设计或进行优化,所有它们以主动/被动配置的模式运行更佳。如果逻辑卷被镜像了,选择在群集逻辑卷上运行不是集群感知的应用程序可能会导致性能下降。这是因为,在这些情况下逻辑卷本身需要有集群通信的额外开销。针对集群设计的应用程序所获得的性能提高幅度必须大于因为集群文件系统和针对集群的逻辑卷所造成的性能降低的幅度。一些应用程序和工作负载会比其他应用程序和工作负载更容易实现这一点。确定集群的要求以及是否要为活跃/主动集群进行优化,从而在两个 LVM 配置间进行选择。大多数用户使用 HA-LVM 一般会获得最佳的 HA 结果。

HA-LVM 和 CLVM 的相似之处在于,它们都会防止 LVM 元数据及其逻辑卷崩溃,如果允许多个机器进行重叠更改,则可能会发生这种情况。HA-LVM 会限制在一个时间点上只能有一个逻辑卷被激活,也就是说一次只在一个机器中激活。这意味着,只使本地(非集群)实现的存储驱动被使用。使用这种方法可以避免用于集群协调的额外开销,以提高性能。CLVM 不强制进行这些限制,用户可以自由地激活集群中所有机器上的逻辑卷;这样会强制使用集群感知型存储驱动程序,允许将集群感知型文件系统和应用程序放在最上面。

1.4.2. 在集群中配置 LVM 卷

在 Red Hat Enterprise Linux 7 中,集群通过 Pacemaker 进行管理。只支持 HA-LVM 和 CLVM 逻辑卷与 Pacemaker 集群配合使用,且必须配置为集群资源。

- 有关将 HA-LVM 卷配置为 Pacemaker 集群一部分的流程,请参阅 高可用性 Add-On 管理 中的 红帽高可用性集群中的主动/被动 Apache HTTP 服务器。请注意,这个流程包括以下步骤:

- 配置 LVM 逻辑卷

- 确保只有集群可以激活卷组

- 将 LVM 卷配置为集群资源

- 有关在集群中配置 CLVM 卷的流程,请参阅 全局文件系统 2 中的 在集群中配置 GFS2 文件系统。

第 2 章 LVM 组件

本章描述了 LVM 逻辑卷的组件。

2.1. 物理卷

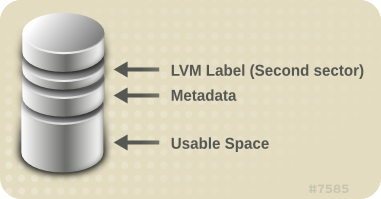

LVM 逻辑卷的基本物理存储单元是块设备,比如一个分区或者整个磁盘。要将设备作为 LVM 逻辑卷使用,需要首先将其初始化为物理卷(PV)。将块设备初始化为物理卷会在接近设备起始的位置放置一个标签。

默认情况下,LVM 标签是放在第二个 512 字节扇区。在创建物理卷时,您可以将标签放置在前 4 个扇区的任何一个上,来覆盖此默认设置。如果需要,LVM 卷可与其它使用这些扇区的用户共同存在。

LVM 标签为物理设备提供正确的识别和设备排序,因为在系统启动时设备可以以任何顺序出现。LVM 标签在重新引导时具有持久性并在整个集群中可用。

LVM 标签可将该设备识别为 LVM 物理卷。它包含物理卷的随机唯一识别符(UUID)。它还以字节为单位保存块设备的大小,并记录 LVM 元数据存储在该设备中的位置。

LVM 元数据包含您系统中 LVM 卷组的配置详情。默认情况下,卷组中的每个物理卷的元数据区域都会保留一个一样的元数据副本。LVM 元数据很小,它以 ASCII 格式保存。

目前,LVM 允许您在每个物理卷中保存 0、1 或者 2 个元数据副本。默认为 1 个副本。当您在物理卷中配置元数据副本数后,您将无法再更改该号码。第一个副本保存在设备的起始位置,紧随在标签后面。如果有第二个副本,会将其放在设备的末尾。如果您不小心写入了不同于您想要写入的磁盘覆盖了磁盘起始部分,那么您可以使用在设备末尾的元数据的第二个副本恢复元数据。

有关 LVM 元数据以及更改元数据参数的详情,请参考 附录 E, LVM 卷组元数据。

2.1.1. LVM 物理卷布局

图 2.1 “物理卷布局” 显示 LVM 物理卷的布局。LVM 标签在第二个扇区,接下来是元数据区域,后面是设备的可用空间。

注意

在 Linux 内核中(以及整个此文档中),每个扇区的大小为 512K。

图 2.1. 物理卷布局

[D]

2.1.2. 一个磁盘上的多个分区

LVM 允许您在磁盘分区外创建物理卷。红帽建议您创建一个覆盖整个磁盘的单一分区,将其标记为 LVM 物理卷,理由如下:

- 方便管理如果每个真实磁盘只出现一次,那么在系统中追踪硬件就比较容易。特别是当磁盘失败时。另外,单一磁盘中有多个物理卷可导致内核在引导时发出未知分区类型警告。

- 条带化性能LVM 无法告知两个物理卷位于同一个物理磁盘中。如果您在两个物理卷位于同一物理磁盘时创建了条带逻辑卷,那么条带就可能在同一磁盘的不同分区中。这可能会降低性能,而不是提高性能。

虽然不建议您这样做,但在某些情况下可能需要将磁盘分成独立的 LVM 物理卷。例如:在有多个磁盘的系统中,当您要将现有系统迁移到 LVM 卷时,可能需要将数据在分区间转移。另外,如果您有一个很大的磁盘,并且因为管理的原因想要有一个以上卷组,那么对磁盘进行分区是很必要的。如果您的磁盘有一个以上的分区,且这些分区在同一卷组中,在创建条带卷时指定逻辑卷中应包含哪些分区。

2.2. 卷组

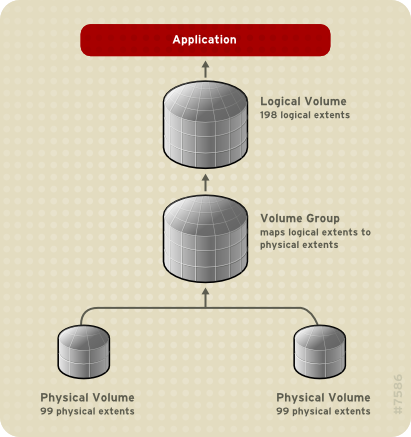

物理卷合并为卷组(VG)。这样就创建了一个磁盘空间池,可使用它分配逻辑卷。

在卷组中,可用于分配的磁盘空间被分成固定大小的单元,我们称之为扩展。一个扩展就是可被分配的最小空间单位。在物理卷中,扩展被称为物理扩展。

逻辑卷被分配成与物理卷扩展大小相同的逻辑扩展。因此卷组中的所有逻辑卷的扩展大小都是一样的。卷组将逻辑扩展与物理扩展匹配。

2.3. LVM 逻辑卷

在 LVM 中,卷组被分成逻辑卷。下面的部分描述了不同类型的逻辑卷类型。

2.3.1. 线性卷

线性卷将来自一个或多个物理卷的空间集合到一个逻辑卷中。例如:如果您有两个 60GB 的磁盘,您可以创建一个 120GB 的逻辑卷。物理存储是连在一起的。

创建一个线性卷,按顺序为逻辑卷的区域分配物理扩展范围。例如:如 图 2.2 “扩展映射” 中所示,逻辑扩展 1 到 99 可映射到一个物理卷,逻辑扩展 100 到 198 可映射到第二个物理卷。从应用程序的角度来看,它是一个大小为 198 个扩展的设备。

图 2.2. 扩展映射

[D]

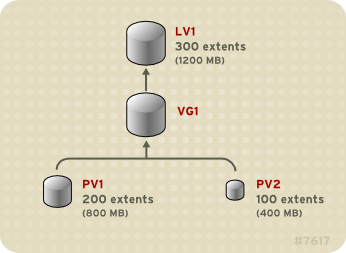

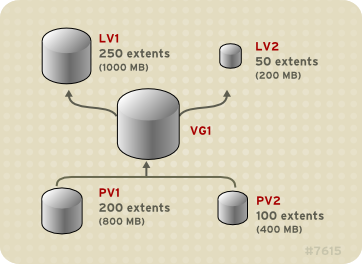

构成逻辑卷的物理卷大小应该相同。图 2.3 “具有不等物理卷的线性卷” 显示卷组

VG1,物理扩展大小为 4MB。这个卷组包括 2 个物理卷,名为 PV1 和 PV2。物理卷被分成 4MB 单元,因为这是扩展的大小。在本例中,PV1 的大小为 200 个扩展(800MB),PV2 的大小为 100 个扩展(400MB)。您可以创建一个大小在 1 到 300 个扩展(4MB 到 1200MB)的线性卷。在这个示例中,名为 LV1 的线性卷的大小为 300 个扩展。

图 2.3. 具有不等物理卷的线性卷

[D]

您可以从物理区块池中配置多个所需大小的线性逻辑卷。图 2.4 “多个逻辑卷” 显示与 图 2.3 “具有不等物理卷的线性卷” 相同的卷组,但在这种情况下,两个逻辑卷已从卷组中分离出来:

LV1,大小为 250 个扩展(1000MB)和 LV2,大小为 50 个扩展(200MB)。

图 2.4. 多个逻辑卷

[D]

2.3.2. 条带逻辑卷

当您向 LVM 逻辑卷写入数据时,文件系统会在基本物理卷之间部署数据。您可以通过创建一个条带逻辑卷来控制将数据写入物理卷的方法。对于大量连续的读取和写入,这样可以提高数据输入/输出的效率。

条带通过以循环模式向预定数目的物理卷写入数据来提高性能。使用条带,I/O 可以并行执行。在某些情况下,这可能会为条带中的每个额外物理卷增加近线性能。

以下示例显示数据在三个物理卷之间进行条带分布。在这个图表中:

- 数据的第一条写入第一个物理卷

- 数据的第二条写入第二个物理卷

- 数据的第三条被写入第三个物理卷

- 数据的第四条写入第一个物理卷

在条带逻辑卷中,条的大小不能超过扩展的大小。

图 2.5. 跨三个 PV 的条带数据

[D]

通过将另一组设备连接到第一个集合的末尾,可以扩展条带逻辑卷。要扩展条带逻辑卷,在基本物理卷集合中必须有足够的可用空间组成卷组来支持条带。例如:如果您有一个双向条带使用了整个卷组,那么向卷组中添加单一物理卷不会允许您扩展条带。反之,您必须在卷组中添加至少两个物理卷。有关扩展条带卷的详情,请参考 第 4.4.17 节 “扩展条带卷”。

2.3.3. RAID 逻辑卷

LVM 支持 RAID0/1/4/5/6/10。LVM RAID 卷有以下特征:

- LVM 使用 MD 内核驱动程序来创建和管理 RAID 逻辑卷。

- RAID1 镜像可以从阵列中临时分离出来,之后再合并回阵列。

- LVM RAID 卷支持快照。

有关创建 RAID 逻辑卷的详情,请参考 第 4.4.3 节 “RAID 逻辑卷”。

注意

RAID 逻辑卷不是集群感知的。虽然可以在一台机器上单独创建和激活 RAID 逻辑卷,但不能在多个机器上同时激活它们。

2.3.4. 精简配置的逻辑卷(精简卷)

逻辑卷可以使用精简模式置备。这可让您创建大于可用扩展的逻辑卷。使用精简配置,您可以管理一个空闲空间的存储池,称为精简池,可在应用程序需要时将其分配给任意数量的设备。然后,当应用程序实际写入逻辑卷时,您可以创建可绑定到精简池的设备以便以后分配。可在需要时动态扩展精简池,以便有效分配存储空间。

注意

不支持集群中跨节点的精简卷。精简池及其所有精简卷必须只在一个集群节点中单独激活。

通过使用精简配置,存储管理员可过量使用物理存储,从而避免购买额外的存储。例如:如果 10 个用户为每个应用程序请求一个 100GB 文件系统,存储管理员可以为每个用户创建一个 100GB 文件系统,但其后端的实际存储可以小于这个大小,它在需要时才使用实际的存储。

注意

在使用精简配置时,存储管理员务必要监控存储池,并在其被完全占用时添加更多容量。

要确定可以使用所有可用空间,LVM 支持数据丢弃功能。这允许重复使用丢弃文件或其他块范围使用的空间。

有关创建精简卷的详情,请参考 第 4.4.5 节 “创建精简配置的逻辑卷”。

精简卷支持新的复制时写入(COW)快照逻辑卷部署,这将允许很多虚拟设备在精简池中共享相同数据。有关精简快照卷的详情,请参考 第 2.3.6 节 “精简配置的快照卷”。

2.3.5. 快照卷

LVM 快照功能提供在特定时间创建设备的虚拟镜像且不会造成服务中断的功能。在提取快照后,当对原始设备进行修改时,快照功能会生成有变化的数据区域的副本,以便重建该设备的状态。

注意

LVM 支持精简配置的快照。有关精简配置快照卷的详情,请参考 第 2.3.6 节 “精简配置的快照卷”。

注意

不支持集群中跨节点的 LVM 快照。您不能在集群卷组中创建快照卷。

因为快照只复制创建快照后修改的数据区域,快照功能需要的存储空间较小。例如,在很少更新的原始卷中,原始容量的 3-5 % 就足以维护快照。

注意

文件系统的快照副本是虚拟副本,不是文件系统的实际介质备份。快照不能替代备份。

预留用来存储原始卷更改的空间的大小取决于快照的大小。例如:如果您要创建快照,且要完全覆盖原始卷,则快照必须至少与原始卷大小方可保存更改。您需要根据预期的更改程度调整快照大小。例如,一个以读为主的卷的短期快照(如

/usr )需要较少的空间,而不是看到大量写入的卷的长期快照,如 /home。

如果快照已满,则快照就会变得无效,因为它无法跟踪原始卷中的更改。您应该定期监控快照的大小。快照可以完全重新定义大小,因此如果您有存储容量,则可以增大快照卷以避免丢失快照。另外,如果您发现快照卷超过您的需要,您可以减小卷的大小来为其它逻辑卷最大限度腾出空间。

当您创建快照文件系统时,仍可对原始系统有完全的读和写访问。如果更改了快照中的块,则会标记那个块,永远不会从原始卷中复制该块。

快照有几个用途:

- 最典型的是。当您需要在逻辑卷中执行备份而不停止持续更新数据的 Live 系统时会提取快照。

- 您可以对快照文件系统执行 fsck 命令来检查文件系统的完整性,并确定原始文件系统是否需要文件系统修复。

- 因为快照是可读/写的,您可以根据产品数据测试应用程序,方法是提取一个快照并根据快照运行测试,从而不会影响真实数据。

- 您可以为 Red Hat Virtualization 创建 LVM 卷。LVM 快照可用来创建虚拟客体镜像的快照。这些快照可方便修改现有客户虚拟机或者使用最小附加存储创建新客户虚拟机。有关使用 Red Hat Virtualization 创建基于 LVM 的存储池的详情,请参考 虚拟化管理指南。

有关创建快照卷的详情,请参考 第 4.4.6 节 “创建快照卷”。

您可以使用 lvconvert 命令的

--merge 选项将快照合并到其原始卷中。这个功能的一个作用是在您丢失数据或者文件或者需要将系统恢复到之前的状态时执行系统恢复。合并快照卷后,得到的逻辑卷将具有原始卷的名称、次号码和 UUID,且合并的快照被删除。有关使用这个选项的详情,请参考 第 4.4.9 节 “合并快照卷”。

2.3.6. 精简配置的快照卷

Red Hat Enterprise Linux 支持精简配置的快照卷。精简快照卷允许将很多虚拟设备保存在同一个数据卷中。这简化了管理过程,并允许在快照卷间共享数据。

除了所有 LVM 快照卷以及所有精简卷一样,集群的节点不支持精简快照卷。快照卷必须在一个集群节点中完全激活。

精简快照卷提供以下优点:

- 当有相同原始卷的多个快照时,精简快照卷就可以减少磁盘用量。

- 如果同一来源有多个快照,对原始卷的写入会导致 COW 操作保留数据。增加原始卷的快照数量应该不会造成很大的性能下降。

- 精简快照卷可用于另一个快照的逻辑卷来源。这允许任意深度的递归快照(快照的快照...)。

- 精简逻辑卷的快照也创建一个精简逻辑卷。在要求 COW 操作前,或直到快照已写入前,并不会消耗数据空间。

- 精简快照卷不需要使用原始卷激活,因此当原始快照卷有很多不活跃时,用户可能只激活原始卷。

- 当您删除精简置备快照卷的原始卷时,该原始卷的每个快照都会变为独立的精简置备卷。这意味着,您不需要将快照与原始卷合并,而不必选择删除原始卷,然后使用该独立卷作为新快照的原始卷创建新置备快照。

虽然使用精简快照卷有很多优点,但在有些情况下,旧的 LVM 快照卷功能可能更适合您的需要:

- 您不能更改精简池的块大小。如果精简池的块大小较大(例如: 1MB),且您需要一个短期存在的快照且使用大块的效率不高时,可以选择使用旧的快照功能。

- 您不能限制精简快照卷的大小 ; 如果需要,快照将使用精简池中所有空间。这可能不适用于您的需要。

一般说来,在决定使用什么快照格式时,您应该考虑具体的要求。

注意

在使用精简配置时,存储管理员务必要监控存储池,并在其被完全占用时添加更多容量。有关配置和显示精简配置的快照卷的信息,请参考 第 4.4.7 节 “创建精简配置的快照卷”。

2.3.7. 缓存卷

在 Red Hat Enterprise Linux 7.1 发行版中,LVM 支持使用快速块设备(如 SSD 驱动器)作为大型慢块设备的 write-back 或 write-through 缓存。用户可以创建缓存逻辑卷来提高其现有逻辑卷的性能,或者创建由小而快速的设备组成的新缓存逻辑卷,再加上一个大型、较慢的设备。

有关创建 LVM 缓存卷的详情,请参考 第 4.4.8 节 “创建 LVM 缓存逻辑卷”。

第 3 章 LVM 管理概述

本章提供了您用来配置 LVM 逻辑卷的管理流程的概述。本章旨在提供一个对所涉及步骤的全面了解。有关常见 LVM 配置流程的具体步骤的示例,请参考 第 5 章 LVM 配置示例。

有关用于执行 LVM 管理的 CLI 命令的描述,请参考 第 4 章 使用 CLI 命令进行 LVM 管理。

3.1. 逻辑卷创建概述

以下是创建 LVM 逻辑卷所要执行的步骤的概述。

- 将要用于 LVM 卷进行分区,来作为物理卷(这会标记它们)。

- 创建卷组。

- 创建逻辑卷。

在创建逻辑卷后,您可以创建并挂载文件系统。本文档中的示例使用了 GFS2 文件系统。

- 使用 mkfs.gfs2 命令在逻辑卷中创建 GFS2 文件系统。

- 使用 mkdir 命令创建新挂载点。在集群系统中,在集群中的所有节点上创建挂载点。

- 挂载文件系统。您可能需要为系统中的每个节点向

fstab文件中添加一行。

注意

虽然 GFS2 文件系统可以在独立系统或作为集群配置的一部分实现,但对于 Red Hat Enterprise Linux 7 版本,红帽不支持将 GFS2 作为单节点文件系统使用。红帽将继续支持单节点 GFS2 文件系统来挂载集群文件系统的快照(例如用于备份目的)。

创建 LVM 卷与机器无关,因为 LVM 设置信息的存储区域位于物理卷上,而不是创建卷的机器上。使用存储的服务器有本地副本,但可以从其所在的物理卷上重新创建。如果 LVM 版本是兼容的,您可以将物理卷附加到不同的服务器上。

3.2. 增大逻辑卷上的文件系统

要在逻辑卷中增大文件系统,执行以下步骤:

- 确定现有卷组中是否有足够的未分配空间来扩展逻辑卷。如果没有,执行以下步骤:

- 使用 pvcreate 命令创建一个新的物理卷。

- 使用 vgextend 命令扩展卷组,该卷组包含您要增大的文件系统的逻辑卷,使其包含新的物理卷。

- 当卷组足够大以包含更大的文件系统后,使用 lvresize 命令扩展逻辑卷。

- 在逻辑卷中重新定义文件系统大小。

请注意,您可以使用 lvresize 命令的

-r 选项扩展逻辑卷并使用单个命令重新定义基础文件系统大小

3.3. 逻辑卷备份

每当卷组或逻辑卷有配置更改时,会自动创建元数据备份和存档,除非此功能在

lvm.conf 文件中被禁用。默认情况下,元数据备份存储在 /etc/lvm/backup 文件中,元数据存档存储在 /etc/lvm/archive 文件中。保存 /etc/lvm/archive 文件中存储的元数据存档的时长,以及保存多少存档文件由您可以在 lvm.conf 文件中设置的参数决定。每日系统备份应该在备份中包含 /etc/lvm 目录的内容。

请注意,元数据备份不会备份包含在逻辑卷中的用户和系统数据。

您可以使用 vgcfgbackup 命令将元数据手动备份到

/etc/lvm/backup 文件中。您可以使用 vgcfgrestore 命令恢复元数据。vgcfgbackup 和 vgcfgrestore 命令在 第 4.3.13 节 “备份卷组元数据” 中进行了描述。

3.4. 日志记录

所有消息输出都通过一个日志模块,该模块对以下情况具有日志级别的独立选择:

- 标准输出/错误

- syslog

- 日志文件

- 外部日志功能

日志级别在

/etc/lvm/lvm.conf 文件中设置,该文件在 附录 B, LVM 配置文件 中进行了描述。

3.5. 元数据守护进程(lvmetad)

LVM 可以选择使用中央元数据缓存,通过守护进程(lvmetad)和

udev 规则实现。元数据守护进程有两个主要目的:它提高了 LVM 命令的性能,并允许 udev 在逻辑卷或整个卷组系统可用时自动激活它们。

当

lvm.conf 配置文件中的 global/use_lvmetad 变量被设置为 1 时,LVM 被配置为使用守护进程。这是默认值。有关 lvm.conf 配置文件的详情,请参考 附录 B, LVM 配置文件。

注意

目前跨集群节点不支持 lvmetad 守护进程,需要锁定类型是基于文件的本地锁定。当您使用 lvmconf --enable-cluster/-disable-cluster 命令时,

lvm.conf 文件会被正确配置,包括 use_lvmetad 设置(对于 locking_type=3,它应该是 0)。但请注意,在 Pacemaker 集群中,oc f:heartbeat:clvm 资源代理本身将这些参数设置为启动过程的一部分。

如果将

use_lvmetad 的值从 1 改为 0,则必须使用以下命令手动重启或停止 lvmetad 服务。

# systemctl stop lvm2-lvmetad.service

通常,每个 LVM 命令都会发出一个磁盘扫描,以查找所有相关物理卷,并读取卷组元数据。但是,如果元数据守护进程正在运行且已启用,则可以跳过此昂贵的扫描。相反,lvmetad 守护进程只扫描每个设备一次,当它可用时,使用

udev 规则。这可节省大量 I/O,并减少完成 LVM 操作所需的时间,特别是对于有多个磁盘的系统。

当在运行时新卷组可用时(例如,通过热插拔或 iSCSI),必须激活其逻辑卷才使其可用。当启用 lvmetad 守护进程时,

lvm.conf 配置文件中的 activation/auto_activation_volume_list 选项可以用来配置卷组列表或应自动激活的逻辑卷。如果没有 lvmetad 守护进程,则需要激活。

注意

当 lvmetad 守护进程运行时,

/etc/lvm/lvm.conf 文件中的 filter = 设置不会在执行 pvscan --cache device 命令时应用。要过滤设备,您需要使用 global_filter = 设置。未通过全局筛选,且不会被 LVM 打开的设备,永远不会被扫描。例如,您可能需要使用全局过滤器,例如,当在虚拟机中使用 LVM 设备,且您不希望虚拟机中设备的内容被物理主机扫描时。

3.6. 使用 lvm 命令显示 LVM 信息

lvm 命令提供了几个内置选项,可用于显示有关 LVM 支持和配置的信息。

- LVM devtypes显示可识别的内置块设备类型(Red Hat Enterprise Linux 版本 6.6 及更新的版本)。

- LVM 格式显示可识别的元数据格式。

- LVM 帮助显示 LVM 帮助文本。

- LVM segtypes显示可识别的逻辑卷片段类型。

- LVM 标签显示此主机上定义的所有标签。有关 LVM 对象标签的详情,请参考 附录 D, LVM Object Tags。

- LVM 版本显示当前版本信息。

第 4 章 使用 CLI 命令进行 LVM 管理

本章总结了您可以使用 LVM 命令行界面(CLI)命令创建和维护逻辑卷执行的各个管理任务。

除了 LVM 命令行界面(CLI)外,您还可以使用系统存储管理器(SSM)来配置 LVM 逻辑卷。有关 SSM 与 LVM一起使用的详情,请参考 存储管理指南。

4.1. 使用 CLI 命令

所有 LVM CLI 命令都有一些通用功能。

当在命令行参数中需要大小时,可以明确指定其单位。如果您没有指定单位,那么就使用默认单位,通常为 KB 或者 MB。LVM CLI 命令不接受分数。

当在命令行参数中指定单位时,LVM 是不区分大小写的, M 和 m 是相同的,例如,都代表单位是 1024。但是,当在命令中指定

--units 参数时,小写表示该单位是 1024 的倍数,而大写表示该单位是 1000 的倍数。

如果命令使用卷组或者逻辑卷名称作为参数,则完整路径名称是可选的。在名为

vg0 的卷组中,名为 lvol0 的逻辑卷可以指定为 vg0/lvol0。当需要卷组列表但为空时,则使用所有卷组的列表替代。当需要列出逻辑卷但提供了一个卷组,则使用在那个卷组中的所有逻辑卷列表替代。例如,lvdisplay vg0 命令将显示卷组 vg0 中的所有逻辑卷。

所有 LVM 命令都接受

-v 参数,该参数可输入多次来增加输出的详细程度。例如,以下示例显示了 lvcreate 命令的默认输出。

# lvcreate -L 50MB new_vg

Rounding up size to full physical extent 52.00 MB

Logical volume "lvol0" created

以下命令显示带有

-v 参数的 lvcreate 命令的输出。

# lvcreate -v -L 50MB new_vg

Finding volume group "new_vg"

Rounding up size to full physical extent 52.00 MB

Archiving volume group "new_vg" metadata (seqno 4).

Creating logical volume lvol0

Creating volume group backup "/etc/lvm/backup/new_vg" (seqno 5).

Found volume group "new_vg"

Creating new_vg-lvol0

Loading new_vg-lvol0 table

Resuming new_vg-lvol0 (253:2)

Clearing start of logical volume "lvol0"

Creating volume group backup "/etc/lvm/backup/new_vg" (seqno 5).

Logical volume "lvol0" created

您也可以使用

-vv、-vvv 或 -vvv 参数来显示有关命令执行的更多详细信息。-vvvv 参数提供当前的最大信息量。以下示例显示了 lvcreate 命令的输出行前几行,并指定了 -vvvv 参数。

# lvcreate -vvvv -L 50MB new_vg

#lvmcmdline.c:913 Processing: lvcreate -vvvv -L 50MB new_vg

#lvmcmdline.c:916 O_DIRECT will be used

#config/config.c:864 Setting global/locking_type to 1

#locking/locking.c:138 File-based locking selected.

#config/config.c:841 Setting global/locking_dir to /var/lock/lvm

#activate/activate.c:358 Getting target version for linear

#ioctl/libdm-iface.c:1569 dm version OF [16384]

#ioctl/libdm-iface.c:1569 dm versions OF [16384]

#activate/activate.c:358 Getting target version for striped

#ioctl/libdm-iface.c:1569 dm versions OF [16384]

#config/config.c:864 Setting activation/mirror_region_size to 512

...

您可以使用命令的

--help 参数来显示任何 LVM CLI 命令的帮助信息。

# commandname --help

要显示某个命令的手册页,请执行 man 命令:

# man commandname

man lvm 命令提供有关 LVM 的通用在线信息。

所有 LVM 对象都通过 UUID 在内部引用,该 UUID 是在创建对象时分配的。当您删除属于卷组一部分的

/dev/sdf 物理卷时,这非常有用,当您将其插入时,您会发现它现在是 /dev/sdk。LVM 仍然会发现物理卷,因为它通过其 UUID 而不是其设备名称来识别物理卷。有关在创建物理卷时指定物理卷 UUID 的详情,请参考 第 6.3 节 “恢复物理卷元数据”。

4.2. 物理卷管理

这部分描述了执行物理卷管理的各个方面的命令。

4.2.1. 创建物理卷

以下子章节描述了用于创建物理卷的命令。

4.2.1.1. 设置分区类型

如果您将整个磁盘作为您的物理卷使用,那么磁盘就不能有分区表。对于 DOS 磁盘分区,应该使用 fdisk 或 cfdisk 命令或对等命令将分区 id 设置为 0x8e。对于整个磁盘设备,分区表必须被删除,这样会有效地破坏磁盘中的所有数据。您可以用以下命令将现有分区表的第一个扇区归零来删除分区表:

# dd if=/dev/zero of=PhysicalVolume bs=512 count=14.2.1.2. 初始化物理卷

使用 pvcreate 命令初始化要用作物理卷的块设备。初始化与格式化文件系统类似。

以下命令将

/dev/sdd、/dev/sde、/dev/sdf 初始化为 LVM 物理卷,以便稍后用作 LVM 逻辑卷的一部分。

# pvcreate /dev/sdd /dev/sde /dev/sdf

要初始化分区而不是整个磁盘:请在分区上运行 pvcreate 命令。以下示例将分区

/dev/hdb1 初始化为 LVM 物理卷,以便稍后用作 LVM 逻辑卷的一部分。

# pvcreate /dev/hdb14.2.1.3. 扫描块设备

您可以使用 lvmdiskscan 命令扫描可用作物理卷的块设备,如下例所示。

# lvmdiskscan

/dev/ram0 [ 16.00 MB]

/dev/sda [ 17.15 GB]

/dev/root [ 13.69 GB]

/dev/ram [ 16.00 MB]

/dev/sda1 [ 17.14 GB] LVM physical volume

/dev/VolGroup00/LogVol01 [ 512.00 MB]

/dev/ram2 [ 16.00 MB]

/dev/new_vg/lvol0 [ 52.00 MB]

/dev/ram3 [ 16.00 MB]

/dev/pkl_new_vg/sparkie_lv [ 7.14 GB]

/dev/ram4 [ 16.00 MB]

/dev/ram5 [ 16.00 MB]

/dev/ram6 [ 16.00 MB]

/dev/ram7 [ 16.00 MB]

/dev/ram8 [ 16.00 MB]

/dev/ram9 [ 16.00 MB]

/dev/ram10 [ 16.00 MB]

/dev/ram11 [ 16.00 MB]

/dev/ram12 [ 16.00 MB]

/dev/ram13 [ 16.00 MB]

/dev/ram14 [ 16.00 MB]

/dev/ram15 [ 16.00 MB]

/dev/sdb [ 17.15 GB]

/dev/sdb1 [ 17.14 GB] LVM physical volume

/dev/sdc [ 17.15 GB]

/dev/sdc1 [ 17.14 GB] LVM physical volume

/dev/sdd [ 17.15 GB]

/dev/sdd1 [ 17.14 GB] LVM physical volume

7 disks

17 partitions

0 LVM physical volume whole disks

4 LVM physical volumes

4.2.2. 显示物理卷

您可以使用三个命令来显示 LVM 物理卷的属性: pvs、pvdisplay 和 pvscan。

pvdisplay 命令为每个物理卷提供详细的多行输出。它以固定格式显示物理属性(大小、扩展、卷组等等)。

以下示例显示了单个物理卷的 pvdisplay 命令的输出。

# pvdisplay

--- Physical volume ---

PV Name /dev/sdc1

VG Name new_vg

PV Size 17.14 GB / not usable 3.40 MB

Allocatable yes

PE Size (KByte) 4096

Total PE 4388

Free PE 4375

Allocated PE 13

PV UUID Joqlch-yWSj-kuEn-IdwM-01S9-XO8M-mcpsVe

pvscan 命令扫描系统中所有支持的物理卷 LVM 块设备。

以下命令显示所有找到的物理设备:

# pvscan

PV /dev/sdb2 VG vg0 lvm2 [964.00 MB / 0 free]

PV /dev/sdc1 VG vg0 lvm2 [964.00 MB / 428.00 MB free]

PV /dev/sdc2 lvm2 [964.84 MB]

Total: 3 [2.83 GB] / in use: 2 [1.88 GB] / in no VG: 1 [964.84 MB]

您可以在

lvm.conf 文件中定义过滤器,以便这个命令避免扫描特定的物理卷。有关使用过滤器来控制扫描哪些设备的详情,请参考 第 4.5 节 “使用过滤器控制 LVM 设备扫描”。

4.2.3. 防止在物理卷上分配

您可以使用 pvchange 命令防止在一个或多个物理卷的空闲空间上分配物理扩展。这在出现磁盘错误或者要删除物理卷时是必需的。

以下命令不允许在

/dev/sdk1 上分配物理扩展。

# pvchange -x n /dev/sdk1

您也可以使用 pvchange 命令的

-xy 参数来允许在之前禁止的物理扩展上分配。

4.2.4. 重新调整物理卷大小

如果您需要出于某种原因更改底层块设备的大小,请使用 pvresize 命令来使用新大小更新 LVM。您可以在 LVM 正在使用物理卷时执行这个命令。

4.2.5. 删除物理卷

如果 LVM 不再需要某个设备,您可以使用 pvremove 命令删除 LVM 标签。执行 pvremove 命令会将空物理卷上的 LVM 元数据归零。

如果您要删除的物理卷目前是卷组的一部分,则必须使用 vgreduce 命令将其从卷组中删除,如 第 4.3.7 节 “从卷组中删除物理卷” 所述。

# pvremove /dev/ram15

Labels on physical volume "/dev/ram15" successfully wiped

4.3. 卷组管理

这部分描述了执行卷组管理的各个方面的命令。

4.3.1. 创建卷组

以下命令创建一个名为

vg1 的卷组,其包含物理卷 /dev/sdd1 和 /dev/sde1。

# vgcreate vg1 /dev/sdd1 /dev/sde1

当使用物理卷创建卷组时,默认情况下它的磁盘空间被分成 4MB 扩展。这个扩展是增大或者减小逻辑卷容量的最小值。大量的扩展不会影响逻辑卷的 I/O 性能。

如果默认扩展大小不合适,您可以在 vgcreate 命令中使用

-s 选项,来指定扩展大小。您可以使用 vgcreate 命令的 -p 和 -l 参数来限制卷组的物理或者逻辑卷数量。

默认情况下,卷组根据常识分配物理扩展,比如不会将平行条带放在同一个物理卷中。这是 normal 分配策略。您可以使用 vgcreate 命令的 --alloc 参数来指定contiguous 、anywhere 或 cling 的分配策略。通常,只在特殊情况下需要指定非通常或非标准扩展分配时,才需要不同于 normal 的分配策略。有关 LVM 如何分配物理扩展的详情,请参考 第 4.3.2 节 “LVM 分配”。

LVM 卷组和底层逻辑卷包含在

/dev 目录中的设备特殊文件目录树中,包括以下布局:

/dev/vg/lv/

例如,如果您创建两个卷组

myvg1 和 myvg2,每个卷组都有三个名为 lv01、lv02 和 lv03 的逻辑卷,这将创建六个设备特殊文件:

/dev/myvg1/lv01 /dev/myvg1/lv02 /dev/myvg1/lv03 /dev/myvg2/lv01 /dev/myvg2/lv02 /dev/myvg2/lv03

如果相应的逻辑卷目前没有激活,则设备特殊文件不会出现。

在 64 位 CPU 上,LVM 的最大设备大小为 8 Exabytes。

4.3.2. LVM 分配

当 LVM 操作需要为一个或多个逻辑卷分配物理扩展时,分配过程如下:

- 生成卷组中的未分配物理扩展的完整集以供考虑。如果您在命令行末尾提供任意物理扩展范围,则只考虑指定物理卷中的未分配物理扩展。

- 每个分配策略依次尝试,从最严格的策略(

contiguous)开始,以使用--alloc选项指定的分配策略结束,或者将其设为特定逻辑卷或卷组的默认策略。对于每个策略,使用需要填充的空逻辑卷空间的最小数值逻辑扩展进行工作,并尽量根据分配策略实施的限制分配空间。如果需要更多空间,LVM 会进入下一个策略。

分配策略的限制如下:

contiguous分配政策要求不是逻辑卷的第一个逻辑扩展的任何逻辑扩展的物理位置紧邻它前面的逻辑扩展的物理位置。当逻辑卷为条带或镜像时,contiguous分配限制将独立应用于每个需要空间的条带或镜像(leg)。cling分配策略要求将用于任何逻辑卷的物理卷添加到现有逻辑卷中,该逻辑卷至少已被之前那个逻辑卷中的一个逻辑扩展使用。如果定义了配置参数allocation/cling_tag_list,那么在两个物理卷上都存在任何列出的标签,则两个物理卷将被视为匹配。这允许对有类似属性(比如其物理位置)的物理卷组进行标记并视为分配的目的。有关将 cling 策略与 LVM 标签结合使用的更多信息,以指定在扩展 LVM 卷时要使用的额外物理卷,请参阅 第 4.4.19 节 “使用clingAllocation 策略扩展逻辑卷”。当逻辑卷是条带或镜像时,cling分配限制将独立应用于每个需要空间的条带或镜像(leg)。normal分配策略将不会选择共享同一物理卷的物理扩展,因为逻辑扩展已分配给了位于该并行逻辑卷内的同一偏移处的并行逻辑卷(即不同的条带或镜像/leg)。当在逻辑卷保存镜像数据时分配镜像日志,normal分配策略首先会尝试为日志和数据选择不同的物理卷。如果这不可能,并且allocation/mirror_logs_require_separate_pvs配置参数被设为 0,则它将允许日志与部分数据共享物理卷。同样,在分配精简池元数据时,normal分配策略会遵循与分配镜像日志一样的考虑,具体取决于allocation/thin_pool_metadata_require_separate_pvs配置参数。- 如果有足够的可用扩展来满足分配请求,但 normal 分配策略不使用它们,而anywhere 分配策略将使用它们,即使这样会因为在同一个物理卷上放置了两个条带而降低了性能。

可使用 vgchange 命令更改分配策略。

注意

如果您使用没有包括在此文档中的分配策略,应该注意,它们的行为在将来的版本中可能会改变。例如:如果您在命令行中提供两个空物理卷,它们有相同数量的可用物理扩展可用于分配,LVM 当前会以它们列出的顺序处理它们,但不保证在将来的版本中这个行为不会有变化。如果为特定逻辑卷获取特定的布局非常重要,然后您应该通过一系列 lvcreate 和 lvconvert 步骤来构建它,以便应用到每一步骤的分配策略不让 LVM 对布局有任何自由支配权。

要查看任何特定情况下分配过程当前的工作方式,您可以读取调试日志输出,例如,将

-vvvv 选项添加到命令中。

4.3.3. 在集群中创建卷组

您可以使用 vgcreate 命令在集群环境中创建 CLVM 卷组,就像在单一节点上创建它们一样。

注意

在 Red Hat Enterprise Linux 7 中,集群通过 Pacemaker 进行管理。集群式 LVM 逻辑卷只在与 Pacemaker 集群一起使用才被支持,且必须配置为集群资源。有关在集群中配置 LVM 卷的通用信息,请参考 第 1.4 节 “红帽高可用性集群中的 LVM 逻辑卷”。

应使用 vgcreate -cy 或 vgchange -cy 命令设置的集群属性创建由集群成员共享的卷组。如果 CLVMD 正在运行,则会自动设置集群属性。这个集群属性表示这个卷组应该由 CLVMD 管理和保护。在创建任何未由集群共享的卷组且应仅对单个主机可见时,应使用 vgcreate -cn 或 vgchange -cn 命令禁用此集群属性。

默认情况下,使用集群属性在共享存储上创建的卷组对于可以访问共享存储的所有计算机都可见。但是,可以使用 vgcreate 命令的

-cn 选项创建本地卷组,使其仅对集群中的一个节点可见。

以下命令在集群环境中执行时,会创建一个卷组,该卷组与执行命令的节点同属本地。该命令创建名为

vg1 的本地卷,其中包含物理卷 /dev/sdd1 和 /dev/sde1。

# vgcreate -c n vg1 /dev/sdd1 /dev/sde1

您可以使用 vgs 命令检查现有卷组是否为集群卷组,如果卷是集群的集群,则会显示 c 属性。以下命令显示卷组

VolGroup00 和 testvg1 的属性。在本例中,VolGroup00 不是集群,而 testvg1 是集群的集群,如 Attr 标题下的 c 属性所示。

# vgs

VG #PV #LV #SN Attr VSize VFree

VolGroup00 1 2 0 wz--n- 19.88G 0

testvg1 1 1 0 wz--nc 46.00G 8.00M

4.3.4. 向卷组中添加物理卷

要向现有卷组中添加额外的物理卷,请使用 vgextend 命令。vgextend 命令通过添加一个或多个可用物理卷来增加卷组的容量。

以下命令将物理卷

/dev/sdf1 添加到卷组 vg1 中。

# vgextend vg1 /dev/sdf14.3.5. 显示卷组

您可以使用两个命令来显示 LVM 卷组的属性: vgs 和 vgdisplay。

vgdisplay 命令以固定格式显示卷组属性(如大小、扩展、物理卷数目等等)。以下示例显示了卷组

new_vg 的 vgdisplay 命令的输出。如果您没有指定卷组,则会显示所有现有的卷组。

# vgdisplay new_vg

--- Volume group ---

VG Name new_vg

System ID

Format lvm2

Metadata Areas 3

Metadata Sequence No 11

VG Access read/write

VG Status resizable

MAX LV 0

Cur LV 1

Open LV 0

Max PV 0

Cur PV 3

Act PV 3

VG Size 51.42 GB

PE Size 4.00 MB

Total PE 13164

Alloc PE / Size 13 / 52.00 MB

Free PE / Size 13151 / 51.37 GB

VG UUID jxQJ0a-ZKk0-OpMO-0118-nlwO-wwqd-fD5D32

4.3.6. 扫描卷组的磁盘来构建缓存文件

vgscan 命令扫描系统中所有支持的磁盘设备查找 LVM 物理卷和卷组。这会在

/etc/lvm/cache/.cache 文件中构建 LVM 缓存文件,该文件维护了当前 LVM 设备的列表。

LVM 在系统启动时自动启动 vgscan 命令,并在 LVM 操作过程中自动运行 vgscan 命令,比如当您执行 vgcreate 命令时,或者 LVM 检测到不一致时。

注意

当您更改硬件配置并从节点添加或删除设备时,您可能需要手动运行 vgscan 命令,从而导致系统引导时不存在的新设备可见。这可能是必要的,例如,当您向 SAN 上的系统添加新磁盘时,或热插拔一个已标记为物理卷的新磁盘时。

您可以在

/etc/lvm/lvm.conf 文件中定义过滤器,以限制扫描以避免特定设备。有关使用过滤器来控制扫描哪些设备的详情,请参考 第 4.5 节 “使用过滤器控制 LVM 设备扫描”。

以下示例显示了 vgscan 命令的输出。

# vgscan

Reading all physical volumes. This may take a while...

Found volume group "new_vg" using metadata type lvm2

Found volume group "officevg" using metadata type lvm2

4.3.7. 从卷组中删除物理卷

要从卷组中删除未使用的物理卷,请使用 vgreduce 命令。vgreduce 命令通过删除一个或多个空物理卷来缩小卷组的容量。这样就可以使不同的卷组自由使用那些物理卷,或者将其从系统中删除。

在从卷组中删除物理卷前,您可以使用 pvdisplay 命令确定物理卷没有被任何逻辑卷使用。

# pvdisplay /dev/hda1

-- Physical volume ---

PV Name /dev/hda1

VG Name myvg

PV Size 1.95 GB / NOT usable 4 MB [LVM: 122 KB]

PV# 1

PV Status available

Allocatable yes (but full)

Cur LV 1

PE Size (KByte) 4096

Total PE 499

Free PE 0

Allocated PE 499

PV UUID Sd44tK-9IRw-SrMC-MOkn-76iP-iftz-OVSen7

如果物理卷仍在使用,则必须使用 pvmove 命令将数据迁移到另一个物理卷中。然后使用 vgreduce 命令删除物理卷。

以下命令从卷组

my_volume_group 中删除物理卷 /dev/hda1。

# vgreduce my_volume_group /dev/hda1

如果逻辑卷包含失败的物理卷,您就无法使用该逻辑卷。要从卷组中删除缺少的物理卷,您可以使用 vgreduce 命令的

--removemissing 参数,如果缺少的物理卷上没有分配逻辑卷。

如果失败的物理卷包含镜像段类型的逻辑卷的镜像,您可以使用 vgreduce --removemissing --mirrorsonly --force 命令从镜像中删除该镜像。

有关从 LVM 镜像故障中恢复的详情,请参考 第 6.2 节 “从 LVM 镜像故障中恢复”。有关从卷组中删除丢失的物理卷的详情,请参考 第 6.5 节 “从卷组中删除丢失的物理卷”

4.3.8. 激活和停用卷组

当您创建卷组时,默认它是激活的。这意味着,那个组中的逻辑卷是可以访问的,并可以更改。

有一些情况您需要将卷组设为非活动状态,从而不为内核所知。要取消激活或激活卷组,请使用 vgchange 命令的

-a (--available)参数。

以下示例将停用卷组

my_volume_group。

# vgchange -a n my_volume_group

如果启用了集群锁定,请添加"e"来激活或停用只在一个节点上的卷组,或添加"l"来激活或/停用只在本地节点上的卷组。具有单主机快照的逻辑卷总是被专门激活,因为它们一次只能在一个节点上使用。

您可以使用 lvchange 命令取消激活独立逻辑卷,如 第 4.4.11 节 “更改逻辑卷组的参数” 所述,有关激活集群中单个节点上的逻辑卷的信息,请参阅 第 4.7 节 “激活集群中单个节点上的逻辑卷”。

4.3.9. 更改卷组的参数

vgchange 命令用于停用和激活卷组,如 第 4.3.8 节 “激活和停用卷组” 所述。您也可以使用此命令更改现有卷组的几个卷组参数。

以下命令将卷组

vg00 的最大逻辑卷数改为 128。

# vgchange -l 128 /dev/vg00

有关您可以使用 vgchange 命令更改的卷组参数的描述,请查看 vgchange (8)手册页。

4.3.10. 删除卷组

要删除不包含逻辑卷的卷组,请使用 vgremove 命令。

# vgremove officevg

Volume group "officevg" successfully removed

4.3.11. 分割卷组

要分割卷组的物理卷并创建新卷组,请使用 vgsplit 命令。

逻辑卷不能在卷组之间分割。每个现有逻辑卷都必须完全在构成旧的或新卷组的物理上。但是,您可以使用 pvmove 命令来强制进行分割。

以下示例将新卷组

smallvg 从原始卷组 bigvg 中分割。

# vgsplit bigvg smallvg /dev/ram15

Volume group "smallvg" successfully split from "bigvg"

4.3.12. 合并卷组

要将两个卷组合并为一个卷组,请使用 vgmerge 命令。如果这两个卷的物理扩展大小相等,且两个卷组的物理卷和逻辑卷的描述符合目的卷组的限制,您可以将一个不活跃的"源"卷与一个活跃或者不活跃的"目标"卷合并。

以下命令将不活跃的卷组

my_vg 合并到活动或不活跃的卷组 databases 中,提供详细的运行时信息。

# vgmerge -v databases my_vg4.3.13. 备份卷组元数据

在对卷组或逻辑卷的每个配置更改时自动创建元数据备份和存档,除非在

lvm.conf 文件中禁用了。默认情况下,元数据备份存储在 /etc/lvm/backup 文件中,元数据存档存储在 /etc/lvm/archive 文件中。您可以使用 vgcfgbackup 命令将元数据手动备份到 /etc/lvm/backup 文件中。

vgcfgrestore 命令将卷组的元数据从归档恢复到卷组中的所有物理卷。

有关使用

vgcfgrestore 命令恢复物理卷元数据的示例,请参考 第 6.3 节 “恢复物理卷元数据”。

4.3.14. 重命名卷组

使用 vgrename 命令重命名现有卷组。

以下任意一个命令将现有卷组

vg02 重命名为 my_volume_group

# vgrename /dev/vg02 /dev/my_volume_group

# vgrename vg02 my_volume_group4.3.15. 将卷组移动到另一个系统

您可以将整个 LVM 卷组移动到另一个系统中。建议您在执行此操作时使用 vgexport 和 vgimport 命令。

注意

您可以使用 vgimport 命令的

--force 参数。这可让您导入缺少物理卷的卷组,然后运行 vgreduce --removemissing 命令。

vgexport 命令使系统无法访问不活跃的卷组,这样就可以分离其物理卷。vgimport 命令使得在 vgexport 命令使卷组不活跃后可以再次被机器访问。

要从一个系统移动卷组到另一个系统,,执行以下步骤:

- 确定没有用户正在访问卷组中激活卷中的文件,然后卸载逻辑卷。

- 使用 vgchange 命令的

-a n参数将卷组标记为不活动状态,这样可防止对卷组进行任何进一步的活动。 - 使用 vgexport 命令导出卷组。这样可防止您要将其从中删除的系统访问该卷组。导出卷组后,在执行 pvscan 命令时物理卷将显示为在导出的卷组中,如下例所示。

#

pvscanPV /dev/sda1 is in exported VG myvg [17.15 GB / 7.15 GB free] PV /dev/sdc1 is in exported VG myvg [17.15 GB / 15.15 GB free] PV /dev/sdd1 is in exported VG myvg [17.15 GB / 15.15 GB free] ...当关闭系统时,您可以拔出组成该卷组的磁盘并将其连接到新系统。 - 当磁盘插入道新系统中时,请使用 vgimport 命令来导入卷组,使其可以被新系统访问。

- 使用 vgchange 命令的

-a y参数激活卷组。 - 挂载文件系统使其可使用。

4.3.16. 重新创建卷组目录

要重新创建卷组目录和逻辑卷特殊文件,请使用 vgmknodes 命令。这个命令检查活跃逻辑卷所需的

/dev 目录中的 LVM2 特殊文件。它会创建任何缺少的特殊文件,并删除不使用的文件。

您可以通过为 vgscan 命令指定 mknodes 参数,将 vgmknodes 命令合并到 vgscan 命令中。

4.4. 逻辑卷管理

这部分描述了执行逻辑卷管理的各个方面的命令。

4.4.1. 创建线性逻辑卷

要创建逻辑卷,请使用 lvcreate 命令。如果没有为逻辑卷指定名称,则使用默认名称

lvol#,其中 # 是逻辑卷的内部号。

当您创建逻辑卷时,其是从使用组成卷组的物理卷上的空闲扩展从卷组中切割而成的。通常,逻辑卷会在下一次空闲的基础上用尽底层物理卷上任何可用的空间。修改逻辑卷在物理卷中空闲和重新分配的空间。

下面的命令在卷组

vg1 中创建了一个大小为 10GB 的逻辑卷。

# lvcreate -L 10G vg1

逻辑卷大小的默认单位为 MB。以下命令在卷组

testvg 中创建了一个名为 testlv 的 1500MB 线性逻辑卷,创建块设备 /dev/testvg/testlv。

# lvcreate -L 1500 -n testlv testvg

以下命令从卷组

vg0 中的可用扩展创建一个名为 gfslv 的 50GB 逻辑卷。

# lvcreate -L 50G -n gfslv vg0

您可以使用 lvcreate 命令的

-l 参数来指定逻辑卷的大小(以扩展为单位)。您还可以使用此参数指定相关卷组、逻辑卷或物理卷组大小的百分比。后缀 %VG 表示卷组的总大小,后缀 %FREE 表示卷组中剩余的空闲空间,后缀 %PVS 表示指定的物理卷中的空闲空间。对于快照,其大小使用后缀 %ORIGIN 表示原始卷总大小的百分比,(100%ORIGIN 提供了整个原始卷的空间)。当以百分比表示时,该大小定义了新逻辑卷中逻辑扩展数的上限。在命令完成前,不会确定新 LV 中的逻辑扩展的确切数目。

下面的命令创建了名为

mylv 的逻辑卷,它使用卷组 testvg 中总空间的 60%。

# lvcreate -l 60%VG -n mylv testvg

以下命令创建一个名为

yourlv 的逻辑卷,它使用卷组 testvg 中所有未分配的空间。

# lvcreate -l 100%FREE -n yourlv testvg

您可以使用 lvcreate 命令的

-l 参数来创建使用整个卷组的逻辑卷。创建使用整个卷组的逻辑卷的另一种方法是使用 vgdisplay 命令来查找"Total PE"大小,并将这些结果用作 lvcreate 命令的输入。

以下命令创建名为

mylv 的逻辑卷,其填充了名为 testvg 的卷组。

#vgdisplay testvg | grep "Total PE"Total PE 10230 #lvcreate -l 10230 -n mylv testvg

如果需要删除物理卷,用于创建逻辑卷的底层物理卷非常重要,因此当创建逻辑卷时可能需要考虑这一点。有关从卷组中删除物理卷的详情,请参考 第 4.3.7 节 “从卷组中删除物理卷”。

要创建要从卷组中的特定物理卷分配的逻辑卷,请在 lvcreate 命令行的末尾指定物理卷或卷。以下命令在从物理卷

/dev/sdg1 分配的卷组 testvg 中创建一个名为 testlv 的逻辑卷,

# lvcreate -L 1500 -n testlv testvg /dev/sdg1

您可以指定要用于逻辑卷的物理卷的扩展。以下示例在卷组

testvg 中的物理卷 /dev/sda1 中创建了一个线性逻辑卷 0 到 24 个到物理卷 /dev/sdb1 的第 50 到 124 个扩展。

# lvcreate -l 100 -n testlv testvg /dev/sda1:0-24 /dev/sdb1:50-124

下面的例子在物理卷

/dev/sda1 的扩展 0 到 25 个扩展创建了一个线性逻辑卷,然后在扩展 100 时继续布局逻辑卷。

# lvcreate -l 100 -n testlv testvg /dev/sda1:0-25:100-4.4.2. 创建条带卷

对于大量顺序读和写,创建条带逻辑卷可提高数据 I/O 的效率。有关条带卷的通用信息,请参考 第 2.3.2 节 “条带逻辑卷”。

当您创建条带逻辑卷时,您可以使用 lvcreate 命令的

-i 参数指定条带的数量。这决定了逻辑卷将被条带的物理卷数量。条带的数量不能大于卷组中物理卷的数量(除非使用了 --alloc anywhere 参数)。

如果组成条带逻辑卷的底层物理设备具有不同的大小,则条带卷的最大大小由最小的底层设备决定。例如,在双 leg 的条带中,最大大小为较小设备大小的两倍。在三 leg 条带中,最大大小为最小设备大小的三倍。

下面的命令创建了一个跨 2 个物理卷、条带为 64KB 的条带逻辑卷。逻辑卷大小为 50GB,名为

gfslv,并且从卷组 vg0 中分离出来。

# lvcreate -L 50G -i 2 -I 64 -n gfslv vg0

与线性卷一样,您可以指定您要用于条带的物理卷的扩展。以下命令创建一个跨两个物理卷的条状卷 100 个扩展,名为

stripelv,且位于卷组 testvg 中。条带将使用 /dev/sda1 的 0-49 扇区,以及 /dev/sdb1 的 50-99 扇区。

# lvcreate -l 100 -i 2 -n stripelv testvg /dev/sda1:0-49 /dev/sdb1:50-99

Using default stripesize 64.00 KB

Logical volume "stripelv" created

4.4.3. RAID 逻辑卷

LVM 支持 RAID0/1/4/5/6/10。

注意

RAID 逻辑卷不是集群感知的。虽然可以在一台机器上单独创建和激活 RAID 逻辑卷,但不能在多个机器上同时激活它们。如果需要非独占镜像卷,您必须创建带有

镜像 片段类型的卷,如 第 4.4.4 节 “创建镜像卷” 所述。

表 4.1. RAID 段类型

| 片段类型 | 描述 | ||

|---|---|---|---|

raid1 | RAID1 镜像。当您指定 -m 但没有指定条带时,这是 lvcreate 命令的 --type 参数的默认值。 | ||

raid4 | RAID4 专用奇偶校验磁盘 | ||

raid5 | 与 raid5_ls相同 | ||

raid5_la |

| ||

raid5_ra |

| ||

raid5_ls |

| ||

raid5_rs |

| ||

raid6 | 与 raid6_zr相同 | ||

raid6_zr |

| ||

raid6_nr |

| ||

raid6_nc |

| ||

raid10 |

| ||

raid0/raid0_meta (Red Hat Enterprise Linux 7.3 及更高版本) | 条带。RAID0 以条带大小的单位在多个数据子卷间分布逻辑卷数据。这可以提高性能。如果任何数据子卷失败,逻辑卷数据将会丢失。有关创建 RAID0 卷的详情,请参考 第 4.4.3.1 节 “创建 RAID0 卷(Red Hat Enterprise Linux 7.3 及更新版本)”。 |

对于大多数用户,指定五个可用主类型之一(

raid1、raid4、raid 5、raid6、raid10)应该足够了。

当您创建 RAID 逻辑卷时,LVM 会创建一个元数据子卷,它是阵列中的每个数据或奇偶校验子卷的大小的一个区块。例如,创建一个双向 RAID1 阵列会导致两个元数据子卷(

lv_rmeta_0 和 lv_rmeta_1)以及两个数据子卷(lv_rimage_0 和 lv_rimage_1)。同样,创建三向条带(加 1 个隐式奇偶校验设备)RAID4 会导致 4 个元数据子卷(lv_rmeta_0,lv_rmeta_1,lv_rmeta_2, 和 lv_rmeta_3)和 4 个数据子卷(lv_rimage_0,lv_rimage_1,lv_rimage_2, 和 lv_rimage_3)。

以下命令在卷组

my_vg 中创建一个名为 my_lv 的双向 RAID1 阵列,大小为 1GB。

# lvcreate --type raid1 -m 1 -L 1G -n my_lv my_vg

您可以根据您为

-m 参数指定的值,来创建具有不同副本数的 RAID1 阵列。同样,您可以使用 -i 参数 为 RAID 4/5/6 逻辑卷指定条带数。您还可以使用 -I 参数指定条带大小。

以下命令在卷组

my_vg 中创建一个名为 my_lv 的 RAID5 阵列(3 个条带 + 1 个隐式奇偶校验驱动器),该阵列大小为 1GB。请注意,您可以像您为 LVM 条带卷一样指定条带的数目,自动添加正确的奇偶校验驱动器数目。

# lvcreate --type raid5 -i 3 -L 1G -n my_lv my_vg

以下命令在卷组

my_vg 中创建一个名为 my_lv 的 RAID6 阵列(3 个条带 + 2 个隐式奇偶校验驱动器),该阵列大小为 1GB。

# lvcreate --type raid6 -i 3 -L 1G -n my_lv my_vg

使用 LVM 创建 RAID 逻辑卷后,您可以激活、更改、删除、显示和使用卷,就像使用其它 LVM 逻辑卷一样。

当您创建 RAID10 逻辑卷时,使用

sync 操作初始化逻辑卷所需的后台 I/O 可能会分离对 LVM 设备的其他 I/O 操作,比如对卷组元数据的更新,特别是在创建很多 RAID 逻辑卷时。这会导致其它 LVM 操作速度下降。

您可以通过实施恢复节流来控制 RAID 逻辑卷初始化的速率。您可以使用 lvcreate 命令的

--minrecoveryrate 和 --maxrecoveryrate 选项设置这些操作的最小和最大 I/O 速率来控制执行 sync 操作的速率。如下所示指定这些选项。

--maxrecoveryrate Rate[bBsSkKmMgG]为 RAID 逻辑卷设置最大恢复率,使其不会阻断其他小的 I/O 操作。Rate 被指定为阵列中每个设备的每秒数量。如果没有给出后缀,则会假定为 kiB/sec/device。将恢复率设置为 0 表示它将不被绑定。--minrecoveryrate Rate[bBsSkKmMgG]为 RAID 逻辑卷设置最小恢复率,以确保sync操作的 I/O 达到最小吞吐量,即使存在大量 I/O。Rate 被指定为阵列中每个设备的每秒数量。如果没有给出后缀,则会假定为 kiB/sec/device。

下面的命令创建了双向 RAID10 阵列,有三个条带,大小为 10GB,最大恢复率为 128 kiB/sec/device。该数组名为

my_lv,位于卷组 my_vg 中。

# lvcreate --type raid10 -i 2 -m 1 -L 10G --maxrecoveryrate 128 -n my_lv my_vg

您还可以为 RAID 清理操作指定最小和最大恢复率。有关 RAID 清理的详情,请参考 第 4.4.3.11 节 “清理 RAID 逻辑卷”。

注意

您可以使用 LVM RAID 计算器应用程序生成在 RAID 存储上创建逻辑卷的命令。此应用程序使用您输入的有关当前或计划生成这些命令的存储的信息。LVM RAID 计算器应用程序可在 https://access.redhat.com/labs/lvmraidcalculator/ 中找到。

以下小节描述了您可以对 LVM RAID 设备执行的管理任务:

4.4.3.1. 创建 RAID0 卷(Red Hat Enterprise Linux 7.3 及更新版本)

创建 RAID0 卷的命令格式如下。

lvcreate --type raid0[_meta] --stripes Stripes --stripesize StripeSize VolumeGroup [PhysicalVolumePath ...]

表 4.2. RAID0 命令创建参数

| 参数 | 描述 |

|---|---|

--type raid0[_meta] | 指定 raid0 创建一个没有元数据卷的 RAID0 卷。指定 raid0_meta 创建一个具有元数据卷的 RAID0 卷。因为 RAID0 是不弹性的,所以不需要保存任何已镜像的数据块(如 RAID1/10),或者计算并保存任何奇偶校验块(如 RAID4/5/6)。因此,它不需要元数据卷来保持有关镜像或奇偶校验块重新同步进程的状态。但是,在从 RAID0 转换到 RAID4/5/6/10 时元数据卷是强制的,并指定 raid0_meta 预先分配这些元数据卷以防止相应的分配失败。 |

--stripes Stripes | 指定在其中分割逻辑卷的设备数。 |

--stripesize StripeSize | 以 KB 为单位指定每个条的大小。这是在移动到下一个设备前写入一个设备的数据量。 |

VolumeGroup | 指定要使用的卷组。 |

PhysicalVolumePath ... | 指定要使用的设备。如果没有指定,LVM 将选择 Stripes 选项指定的设备数,每个条带一个。 |

4.4.3.2. 将线性设备转换为 RAID 设备

您可以使用 lvconvert 命令的

--type 参数将现有线性逻辑卷转换为 RAID 设备。

以下命令将卷组

my_vg 中的线性逻辑卷 my_lv 转换为双向 RAID1 阵列。

# lvconvert --type raid1 -m 1 my_vg/my_lv

因为 RAID 逻辑卷由元数据和数据子卷对组成,因此当您将线性设备转换成 RAID1 阵列时,会生成一个新的元数据子卷,并关联到线性卷所在的同一物理卷中的原始逻辑卷之一。额外的镜像在 metadata/data 子卷对中添加。例如:如果原始设备如下:

# lvs -a -o name,copy_percent,devices my_vg

LV Copy% Devices

my_lv /dev/sde1(0)

转换为双向 RAID1 阵列后,该设备包含以下数据和元数据子卷对:

#lvconvert --type raid1 -m 1 my_vg/my_lv#lvs -a -o name,copy_percent,devices my_vgLV Copy% Devices my_lv 6.25 my_lv_rimage_0(0),my_lv_rimage_1(0) [my_lv_rimage_0] /dev/sde1(0) [my_lv_rimage_1] /dev/sdf1(1) [my_lv_rmeta_0] /dev/sde1(256) [my_lv_rmeta_1] /dev/sdf1(0)

如果无法将与原始逻辑卷配对的元数据镜像放在同一个物理卷上,则 lvconvert 将失败。

4.4.3.3. 将 LVM RAID1 逻辑卷转换为 LVM 线性逻辑卷

您可以通过指定

-m0 参数,使用 lvconvert 命令将现有的 RAID1 LVM 逻辑卷转换为 LVM 线性逻辑卷。这会删除所有 RAID 数据子卷以及构成 RAID 阵列的所有 RAID 元数据子卷,保留顶层 RAID1 镜像作为线性逻辑卷。

下面的例子显示了现有的 LVM RAID1 逻辑卷。

# lvs -a -o name,copy_percent,devices my_vg

LV Copy% Devices

my_lv 100.00 my_lv_rimage_0(0),my_lv_rimage_1(0)

[my_lv_rimage_0] /dev/sde1(1)

[my_lv_rimage_1] /dev/sdf1(1)

[my_lv_rmeta_0] /dev/sde1(0)

[my_lv_rmeta_1] /dev/sdf1(0)

以下命令将 LVM RAID1 逻辑卷

my_vg/my_lv 转换为 LVM 线性设备。

#lvconvert -m0 my_vg/my_lv#lvs -a -o name,copy_percent,devices my_vgLV Copy% Devices my_lv /dev/sde1(1)

当您将 LVM RAID1 逻辑卷转换成 LVM 线性卷,,您可以指定要删除的物理卷。以下示例显示了由两个镜像组成的 LVM RAID1 逻辑卷布局:

/dev/sda1 和 /dev/sdb1。在这个示例中,lvconvert 命令指定要删除 /dev/sda1,保留 /dev/sdb1 作为组成线性设备的物理卷。

#lvs -a -o name,copy_percent,devices my_vgLV Copy% Devices my_lv 100.00 my_lv_rimage_0(0),my_lv_rimage_1(0) [my_lv_rimage_0] /dev/sda1(1) [my_lv_rimage_1] /dev/sdb1(1) [my_lv_rmeta_0] /dev/sda1(0) [my_lv_rmeta_1] /dev/sdb1(0) #lvconvert -m0 my_vg/my_lv /dev/sda1#lvs -a -o name,copy_percent,devices my_vgLV Copy% Devices my_lv /dev/sdb1(1)

4.4.3.4. 将镜像的 LVM 设备转换为 RAID1 设备

您可以通过指定

--type raid1 参数,使用 lvconvert 命令将片段类型为 mirror 的现有 LVM 设备转换为 RAID1 LVM 设备。这会将镜像子卷(*_mimagezFCP)重命名为 RAID 子卷(*_rimageuildDefaults)。另外,镜像日志会被移除,并在与对应数据子卷相同的物理卷上为数据子卷创建元数据子卷(*_rmetauildDefaults)。

以下示例显示了镜像逻辑卷

my_vg/my_lv 的布局。

# lvs -a -o name,copy_percent,devices my_vg

LV Copy% Devices

my_lv 15.20 my_lv_mimage_0(0),my_lv_mimage_1(0)

[my_lv_mimage_0] /dev/sde1(0)

[my_lv_mimage_1] /dev/sdf1(0)

[my_lv_mlog] /dev/sdd1(0)

以下命令将镜像逻辑卷

my_vg/my_lv 转换为 RAID1 逻辑卷。

#lvconvert --type raid1 my_vg/my_lv#lvs -a -o name,copy_percent,devices my_vgLV Copy% Devices my_lv 100.00 my_lv_rimage_0(0),my_lv_rimage_1(0) [my_lv_rimage_0] /dev/sde1(0) [my_lv_rimage_1] /dev/sdf1(0) [my_lv_rmeta_0] /dev/sde1(125) [my_lv_rmeta_1] /dev/sdf1(125)

4.4.3.5. 重新调整 RAID 逻辑卷的大小

您可以使用以下方法重新定义 RAID 逻辑卷大小:

- 您可以使用 lvresize 或 lvextend 命令增加任何类型 RAID 逻辑卷的大小。这不会改变 RAID 镜像的数量。对于条带的 RAID 逻辑卷,创建条带 RAID 逻辑卷时可使用同样的条带舍入约束。有关扩展 RAID 卷的详情,请参考 第 4.4.18 节 “扩展 RAID 卷”。

- 您可以使用 lvresize 或 lvreduce 命令减少任何类型的 RAID 逻辑卷的大小。这不会改变 RAID 镜像的数量。与 lvextend 命令一样,当创建条带 RAID 逻辑卷时,应用同样的条带舍入约束。有关减小逻辑卷大小的命令的示例,请参考 第 4.4.16 节 “缩小逻辑卷”。

- 从 Red Hat Enterprise Linux 7.4 开始,您可以使用 lvconvert 命令的

--stripes N参数更改条状 RAID 逻辑卷(raid4/5/6/10)上的条带数。这会通过添加或删除条带的容量来增加或减少 RAID 逻辑卷的大小。请注意,raid10卷只能添加条带。这个功能是 RAID 重塑 功能的一部分,它允许您在保持同样的 RAID 级别的情况下更改 RAID 逻辑卷的属性。有关 RAID 重塑和使用 lvconvert 命令重塑 RAID 逻辑卷的示例,请参考 lvmraid(7)手册页。

4.4.3.6. 更改现有 RAID1 设备中的镜像数

您可以更改现有 RAID1 阵列中的镜像数量,就如同在早期的 LVM 镜像部署中更改镜像数量。使用 lvconvert 命令指定要添加或删除的额外元数据/数据子卷对数。有关在早期 LVM 镜像实现中更改卷配置的详情,请参考 第 4.4.4.4 节 “更改镜像卷配置”。

当您使用 lvconvert 命令向 RAID1 设备添加镜像时,您可以指定生成的设备的镜像总数,或者您可以指定要添加到该设备中的镜像数量。您还可以有选择地指定新元数据/数据镜像对所在的物理卷。

元数据子卷(名为

*_rmetafhir)始终存在于与它们的数据子卷 *_rimageuildDefaults 相同的物理设备上。元数据/数据子卷对不会与 RAID 阵列中另一元数据/数据子卷对创建在同一物理卷上(除非您指定了 --alloc anywhere)。

在 RAID1 卷中添加镜像的命令格式如下:

lvconvert -m new_absolute_count vg/lv [removable_PVs] lvconvert -m +num_additional_images vg/lv [removable_PVs]

例如,以下命令显示 LVM 设备

my_vg/my_lv,它是一个双向 RAID1 阵列:

# lvs -a -o name,copy_percent,devices my_vg

LV Copy% Devices

my_lv 6.25 my_lv_rimage_0(0),my_lv_rimage_1(0)

[my_lv_rimage_0] /dev/sde1(0)

[my_lv_rimage_1] /dev/sdf1(1)

[my_lv_rmeta_0] /dev/sde1(256)

[my_lv_rmeta_1] /dev/sdf1(0)

以下命令将双向 RAID1 设备

my_vg/my_lv 转换为三向 RAID1 设备:

#lvconvert -m 2 my_vg/my_lv#lvs -a -o name,copy_percent,devices my_vgLV Copy% Devices my_lv 6.25 my_lv_rimage_0(0),my_lv_rimage_1(0),my_lv_rimage_2(0) [my_lv_rimage_0] /dev/sde1(0) [my_lv_rimage_1] /dev/sdf1(1) [my_lv_rimage_2] /dev/sdg1(1) [my_lv_rmeta_0] /dev/sde1(256) [my_lv_rmeta_1] /dev/sdf1(0) [my_lv_rmeta_2] /dev/sdg1(0)

当您向 RAID1 阵列中添加镜像时,您可以指定要用于该镜像的物理卷。以下命令将双向 RAID1 设备

my_vg/my_lv 转换为三向 RAID1 设备,指定物理卷 /dev/sdd1 用于阵列:

#lvs -a -o name,copy_percent,devices my_vgLV Copy% Devices my_lv 56.00 my_lv_rimage_0(0),my_lv_rimage_1(0) [my_lv_rimage_0] /dev/sda1(1) [my_lv_rimage_1] /dev/sdb1(1) [my_lv_rmeta_0] /dev/sda1(0) [my_lv_rmeta_1] /dev/sdb1(0) #lvconvert -m 2 my_vg/my_lv /dev/sdd1#lvs -a -o name,copy_percent,devices my_vgLV Copy% Devices my_lv 28.00 my_lv_rimage_0(0),my_lv_rimage_1(0),my_lv_rimage_2(0) [my_lv_rimage_0] /dev/sda1(1) [my_lv_rimage_1] /dev/sdb1(1) [my_lv_rimage_2] /dev/sdd1(1) [my_lv_rmeta_0] /dev/sda1(0) [my_lv_rmeta_1] /dev/sdb1(0) [my_lv_rmeta_2] /dev/sdd1(0)

要从 RAID1 阵列中删除镜像,请使用以下命令。当您使用 lvconvert 命令从 RAID1 设备中删除镜像时,您可以指定生成的设备的镜像总数,或者您可以指定要从该设备中删除的镜像数量。您还可以选择指定要从中删除该设备的物理卷。

lvconvert -m new_absolute_count vg/lv [removable_PVs] lvconvert -m -num_fewer_images vg/lv [removable_PVs]

另外,当镜像及其关联的元数据子卷被删除时,任何带有高数值的镜像都将用来填充被删除卷的位置。如果您从由 lv_rimage_0、

lv_rimage_1 和lv_rimage_1 组成的三向 RAID1 阵列中删除 lv_rimage_ 1,则会产生一个由 lv_rimage_ 0 和 lv_rimage_ 1 组成的 RAID1 阵列。lv_rimage_2 将会被重命名,并接管空插槽,成为 lv_rimage_1。

以下示例显示了一个三向 RAID1 逻辑卷

my_vg/my_lv 的布局。

# lvs -a -o name,copy_percent,devices my_vg

LV Copy% Devices

my_lv 100.00 my_lv_rimage_0(0),my_lv_rimage_1(0),my_lv_rimage_2(0)

[my_lv_rimage_0] /dev/sde1(1)

[my_lv_rimage_1] /dev/sdf1(1)

[my_lv_rimage_2] /dev/sdg1(1)

[my_lv_rmeta_0] /dev/sde1(0)

[my_lv_rmeta_1] /dev/sdf1(0)

[my_lv_rmeta_2] /dev/sdg1(0)

下面的命令可将三向 RAID1 逻辑卷转换成双向 RAID1 逻辑卷。

#lvconvert -m1 my_vg/my_lv#lvs -a -o name,copy_percent,devices my_vgLV Copy% Devices my_lv 100.00 my_lv_rimage_0(0),my_lv_rimage_1(0) [my_lv_rimage_0] /dev/sde1(1) [my_lv_rimage_1] /dev/sdf1(1) [my_lv_rmeta_0] /dev/sde1(0) [my_lv_rmeta_1] /dev/sdf1(0)

以下命令将三向 RAID1 逻辑卷转换成双向 RAID1 逻辑卷,指定包含镜像的物理卷为

/dev/sde1。

#lvconvert -m1 my_vg/my_lv /dev/sde1#lvs -a -o name,copy_percent,devices my_vgLV Copy% Devices my_lv 100.00 my_lv_rimage_0(0),my_lv_rimage_1(0) [my_lv_rimage_0] /dev/sdf1(1) [my_lv_rimage_1] /dev/sdg1(1) [my_lv_rmeta_0] /dev/sdf1(0) [my_lv_rmeta_1] /dev/sdg1(0)

4.4.3.7. 将 RAID 镜像分割为单独的逻辑卷

您可以分离 RAID 逻辑卷的镜像形成新的逻辑卷。分离 RAID 镜像的过程与分离镜像逻辑卷的冗余镜像的过程相同,如 第 4.4.4.2 节 “分离镜像逻辑卷的冗余镜像” 中所述。

分离 RAID 镜像的命令格式如下:

lvconvert --splitmirrors count -n splitname vg/lv [removable_PVs]

和您从现有 RAID1 逻辑卷中删除 RAID 镜像一样(如 第 4.4.3.6 节 “更改现有 RAID1 设备中的镜像数”中所述),当您从设备的中间删除 RAID 数据子卷(及其关联的元数据子卷)时,任何编号较高的镜像将向下移动以填充这个插槽。因此,构成 RAID 阵列的逻辑卷上的索引号将是一个完整的整数序列。

注意

如果 RAID1 阵列还没有同步,您就无法分离 RAID 镜像。

以下示例将双向 RAID1 逻辑卷

my_lv 分成两个线性逻辑卷 my_lv 和 new。

#lvs -a -o name,copy_percent,devices my_vgLV Copy% Devices my_lv 12.00 my_lv_rimage_0(0),my_lv_rimage_1(0) [my_lv_rimage_0] /dev/sde1(1) [my_lv_rimage_1] /dev/sdf1(1) [my_lv_rmeta_0] /dev/sde1(0) [my_lv_rmeta_1] /dev/sdf1(0) #lvconvert --splitmirror 1 -n new my_vg/my_lv#lvs -a -o name,copy_percent,devices my_vgLV Copy% Devices my_lv /dev/sde1(1) new /dev/sdf1(1)

以下示例将三向 RAID1 逻辑卷

my_lv 分成双向 RAID1 逻辑卷 my_lv 和线性逻辑卷 new

#lvs -a -o name,copy_percent,devices my_vgLV Copy% Devices my_lv 100.00 my_lv_rimage_0(0),my_lv_rimage_1(0),my_lv_rimage_2(0) [my_lv_rimage_0] /dev/sde1(1) [my_lv_rimage_1] /dev/sdf1(1) [my_lv_rimage_2] /dev/sdg1(1) [my_lv_rmeta_0] /dev/sde1(0) [my_lv_rmeta_1] /dev/sdf1(0) [my_lv_rmeta_2] /dev/sdg1(0) #lvconvert --splitmirror 1 -n new my_vg/my_lv#lvs -a -o name,copy_percent,devices my_vgLV Copy% Devices my_lv 100.00 my_lv_rimage_0(0),my_lv_rimage_1(0) [my_lv_rimage_0] /dev/sde1(1) [my_lv_rimage_1] /dev/sdf1(1) [my_lv_rmeta_0] /dev/sde1(0) [my_lv_rmeta_1] /dev/sdf1(0) new /dev/sdg1(1)

4.4.3.8. 分割和合并 RAID 镜像

您可以临时分离 RAID1 阵列的镜像以进行只读使用,同时使用

--trackchanges 参数和 lvconvert 命令的 --splitmirrors 参数来跟踪任何更改。这可让您以后将镜像合并到阵列中,同时只重新同步那些自镜像被分割后更改的阵列的部分。

分离 RAID 镜像的 lvconvert 命令的格式如下。

lvconvert --splitmirrors count --trackchanges vg/lv [removable_PVs]

当您使用

--trackchanges 参数分离 RAID 镜像时,您可以指定要分离哪个镜像,但您不能更改要分离的卷的名称。另外,得到的卷有以下限制。

- 创建的新卷为只读。

- 不能调整新卷的大小。

- 不能重命名剩余的数组。

- 不能调整剩余的数组大小。

- 您可以独立激活新卷和剩余的阵列。

您可以通过执行带有

--merge 参数的后续 lvconvert 命令来合并使用 --trackchanges 参数指定的镜像。当您合并镜像时,只有自镜像分割后更改的阵列部分会被重新同步。

合并 RAID 镜像的 lvconvert 命令的格式如下。

lvconvert --merge raid_image

下面的例子创建了 RAID1 逻辑卷,然后在追踪剩余的阵列时从那个卷中分离镜像。

#lvcreate --type raid1 -m 2 -L 1G -n my_lv .vgLogical volume "my_lv" created #lvs -a -o name,copy_percent,devices my_vgLV Copy% Devices my_lv 100.00 my_lv_rimage_0(0),my_lv_rimage_1(0),my_lv_rimage_2(0) [my_lv_rimage_0] /dev/sdb1(1) [my_lv_rimage_1] /dev/sdc1(1) [my_lv_rimage_2] /dev/sdd1(1) [my_lv_rmeta_0] /dev/sdb1(0) [my_lv_rmeta_1] /dev/sdc1(0) [my_lv_rmeta_2] /dev/sdd1(0) #lvconvert --splitmirrors 1 --trackchanges my_vg/my_lvmy_lv_rimage_2 split from my_lv for read-only purposes. Use 'lvconvert --merge my_vg/my_lv_rimage_2' to merge back into my_lv #lvs -a -o name,copy_percent,devices my_vgLV Copy% Devices my_lv 100.00 my_lv_rimage_0(0),my_lv_rimage_1(0),my_lv_rimage_2(0) [my_lv_rimage_0] /dev/sdb1(1) [my_lv_rimage_1] /dev/sdc1(1) my_lv_rimage_2 /dev/sdd1(1) [my_lv_rmeta_0] /dev/sdb1(0) [my_lv_rmeta_1] /dev/sdc1(0) [my_lv_rmeta_2] /dev/sdd1(0)

以下示例在跟踪剩余的阵列更改时从 RAID1 卷中分离镜像,然后将该卷合并回阵列中。

#lvconvert --splitmirrors 1 --trackchanges my_vg/my_lvlv_rimage_1 split from my_lv for read-only purposes. Use 'lvconvert --merge my_vg/my_lv_rimage_1' to merge back into my_lv #lvs -a -o name,copy_percent,devices my_vgLV Copy% Devices my_lv 100.00 my_lv_rimage_0(0),my_lv_rimage_1(0) [my_lv_rimage_0] /dev/sdc1(1) my_lv_rimage_1 /dev/sdd1(1) [my_lv_rmeta_0] /dev/sdc1(0) [my_lv_rmeta_1] /dev/sdd1(0) #lvconvert --merge my_vg/my_lv_rimage_1my_vg/my_lv_rimage_1 successfully merged back into my_vg/my_lv #lvs -a -o name,copy_percent,devices my_vgLV Copy% Devices my_lv 100.00 my_lv_rimage_0(0),my_lv_rimage_1(0) [my_lv_rimage_0] /dev/sdc1(1) [my_lv_rimage_1] /dev/sdd1(1) [my_lv_rmeta_0] /dev/sdc1(0) [my_lv_rmeta_1] /dev/sdd1(0)

从 RAID1 卷分离镜像后,您可以通过发出第二个 lvconvert --splitmirrors 命令,重复在不指定

--trackchanges 参数的情况下分割镜像的初始 lvconvert 命令。这会破坏 --trackchanges 参数创建的链接。

使用

--trackchanges 参数分割镜像后,您无法对该阵列发出后续的 lvconvert --splitmirrors 命令,除非您想永久分割被跟踪的镜像。

以下命令序列分割镜像,跟踪镜像,然后永久分离被跟踪的镜像。

#lvconvert --splitmirrors 1 --trackchanges my_vg/my_lvmy_lv_rimage_1 split from my_lv for read-only purposes. Use 'lvconvert --merge my_vg/my_lv_rimage_1' to merge back into my_lv #lvconvert --splitmirrors 1 -n new my_vg/my_lv#lvs -a -o name,copy_percent,devices my_vgLV Copy% Devices my_lv /dev/sdc1(1) new /dev/sdd1(1)

但请注意,以下命令序列将失败。

#lvconvert --splitmirrors 1 --trackchanges my_vg/my_lvmy_lv_rimage_1 split from my_lv for read-only purposes. Use 'lvconvert --merge my_vg/my_lv_rimage_1' to merge back into my_lv #lvconvert --splitmirrors 1 --trackchanges my_vg/my_lvCannot track more than one split image at a time

同样,以下命令序列也会失败,因为分割镜像不是被跟踪的镜像。

#lvconvert --splitmirrors 1 --trackchanges my_vg/my_lvmy_lv_rimage_1 split from my_lv for read-only purposes. Use 'lvconvert --merge my_vg/my_lv_rimage_1' to merge back into my_lv #lvs -a -o name,copy_percent,devices my_vgLV Copy% Devices my_lv 100.00 my_lv_rimage_0(0),my_lv_rimage_1(0) [my_lv_rimage_0] /dev/sdc1(1) my_lv_rimage_1 /dev/sdd1(1) [my_lv_rmeta_0] /dev/sdc1(0) [my_lv_rmeta_1] /dev/sdd1(0) #lvconvert --splitmirrors 1 -n new my_vg/my_lv /dev/sdc1Unable to split additional image from my_lv while tracking changes for my_lv_rimage_1

4.4.3.9. 设置 RAID 失败策略

LVM RAID 根据

lvm.conf 文件中raid_fault_policy 字段定义的首选项以自动方式处理设备故障。

- 如果将

raid_fault_policy字段设为allocate,系统将尝试使用卷组中的备用设备替换失败的设备。如果没有可用的备用设备,则会向系统日志报告。 - 如果将

raid_fault_policy字段设为warn,系统将产生一个警告,日志将表示有一个设备失败。这使得用户能够决定采取什么行动。

只要有足够的设备支持可用性,RAID 逻辑卷将继续操作。

4.4.3.9.1. 分配 RAID 失败策略

在以下示例中,在

lvm.conf 文件中,raid_fault_policy 字段已被设为 allocate。按如下方式定义 RAID 逻辑卷。

# lvs -a -o name,copy_percent,devices my_vg

LV Copy% Devices

my_lv 100.00 my_lv_rimage_0(0),my_lv_rimage_1(0),my_lv_rimage_2(0)

[my_lv_rimage_0] /dev/sde1(1)

[my_lv_rimage_1] /dev/sdf1(1)

[my_lv_rimage_2] /dev/sdg1(1)

[my_lv_rmeta_0] /dev/sde1(0)

[my_lv_rmeta_1] /dev/sdf1(0)

[my_lv_rmeta_2] /dev/sdg1(0)

如果

/dev/sde 设备失败了,系统日志将显示错误消息。

# grep lvm /var/log/messages

Jan 17 15:57:18 bp-01 lvm[8599]: Device #0 of raid1 array, my_vg-my_lv, has failed.

Jan 17 15:57:18 bp-01 lvm[8599]: /dev/sde1: read failed after 0 of 2048 at

250994294784: Input/output error

Jan 17 15:57:18 bp-01 lvm[8599]: /dev/sde1: read failed after 0 of 2048 at

250994376704: Input/output error

Jan 17 15:57:18 bp-01 lvm[8599]: /dev/sde1: read failed after 0 of 2048 at 0:

Input/output error

Jan 17 15:57:18 bp-01 lvm[8599]: /dev/sde1: read failed after 0 of 2048 at

4096: Input/output error

Jan 17 15:57:19 bp-01 lvm[8599]: Couldn't find device with uuid

3lugiV-3eSP-AFAR-sdrP-H20O-wM2M-qdMANy.

Jan 17 15:57:27 bp-01 lvm[8599]: raid1 array, my_vg-my_lv, is not in-sync.

Jan 17 15:57:36 bp-01 lvm[8599]: raid1 array, my_vg-my_lv, is now in-sync.

由于

raid_fault_policy 字段已被设为 allocate,因此失败的设备将被卷组中的新设备替换。

# lvs -a -o name,copy_percent,devices vg

Couldn't find device with uuid 3lugiV-3eSP-AFAR-sdrP-H20O-wM2M-qdMANy.

LV Copy% Devices

lv 100.00 lv_rimage_0(0),lv_rimage_1(0),lv_rimage_2(0)

[lv_rimage_0] /dev/sdh1(1)

[lv_rimage_1] /dev/sdf1(1)

[lv_rimage_2] /dev/sdg1(1)

[lv_rmeta_0] /dev/sdh1(0)

[lv_rmeta_1] /dev/sdf1(0)

[lv_rmeta_2] /dev/sdg1(0)

请注意,虽然替换了失败的设备,但显示仍指示 LVM 无法找到失败的设备。这是因为虽然从 RAID 逻辑卷中删除了失败的设备,但故障的设备还没有从卷组中删除。要从卷组中删除失败的设备,您可以执行 vgreduce --removemissing VG。

如果

raid_fault_policy 已被设为 allocate,但没有备用设备,则分配将失败,逻辑卷保留原样。如果分配失败,您可以选择修复驱动器,然后停用并激活逻辑卷 ; 这在 第 4.4.3.9.2 节 “警告 RAID 失败策略” 中进行了描述。另外,您可以替换失败的设备,如 第 4.4.3.10 节 “替换 RAID 设备” 中所述。

4.4.3.9.2. 警告 RAID 失败策略

在以下示例中,

lvm.conf 文件中的raid_fault_policy 字段已被设为 warn。按如下方式定义 RAID 逻辑卷。

# lvs -a -o name,copy_percent,devices my_vg

LV Copy% Devices

my_lv 100.00 my_lv_rimage_0(0),my_lv_rimage_1(0),my_lv_rimage_2(0)

[my_lv_rimage_0] /dev/sdh1(1)

[my_lv_rimage_1] /dev/sdf1(1)

[my_lv_rimage_2] /dev/sdg1(1)

[my_lv_rmeta_0] /dev/sdh1(0)

[my_lv_rmeta_1] /dev/sdf1(0)

[my_lv_rmeta_2] /dev/sdg1(0)

如果

/dev/sdh 设备失败,系统日志将显示错误消息。在这种情况下,LVM 将不会自动尝试通过替换其中一个镜像修复 RAID 设备。如果设备失败,您可以使用 lvconvert 命令的 --repair 参数替换该设备,如下所示。

#lvconvert --repair my_vg/my_lv/dev/sdh1: read failed after 0 of 2048 at 250994294784: Input/output error /dev/sdh1: read failed after 0 of 2048 at 250994376704: Input/output error /dev/sdh1: read failed after 0 of 2048 at 0: Input/output error /dev/sdh1: read failed after 0 of 2048 at 4096: Input/output error Couldn't find device with uuid fbI0YO-GX7x-firU-Vy5o-vzwx-vAKZ-feRxfF. Attempt to replace failed RAID images (requires full device resync)? [y/n]:y#lvs -a -o name,copy_percent,devices my_vgCouldn't find device with uuid fbI0YO-GX7x-firU-Vy5o-vzwx-vAKZ-feRxfF. LV Copy% Devices my_lv 64.00 my_lv_rimage_0(0),my_lv_rimage_1(0),my_lv_rimage_2(0) [my_lv_rimage_0] /dev/sde1(1) [my_lv_rimage_1] /dev/sdf1(1) [my_lv_rimage_2] /dev/sdg1(1) [my_lv_rmeta_0] /dev/sde1(0) [my_lv_rmeta_1] /dev/sdf1(0) [my_lv_rmeta_2] /dev/sdg1(0)

请注意,虽然替换了失败的设备,但显示仍指示 LVM 无法找到失败的设备。这是因为虽然从 RAID 逻辑卷中删除了失败的设备,但故障的设备还没有从卷组中删除。要从卷组中删除失败的设备,您可以执行 vgreduce --removemissing VG。

如果设备失败是一个临时故障,或者您可以修复失败的设备,您可以使用 lvchange 命令的

--refresh 选项启动故障设备的恢复。之前,需要停用并激活逻辑卷。

以下命令刷新逻辑卷。

# lvchange --refresh my_vg/my_lv4.4.3.10. 替换 RAID 设备

RAID 跟传统的 LVM 镜像不同。LVM 镜像需要删除失败的设备,或者镜像逻辑卷会挂起。RAID 阵列可在有失败设备的情况下继续运行。实际上,对于 RAID1 以外的 RAID 类型,删除设备意味着将设备转换为较低级别 RAID(例如:从 RAID6 转换为 RAID5,或者从 RAID4 或者 RAID5 转换到 RAID0)。因此,LVM 允许您使用 lvconvert 命令的

--replace 参数替换 RAID 卷中的设备,而不是无条件地删除失败的设备。

lvconvert --replace 的格式如下。

lvconvert --replace dev_to_remove vg/lv [possible_replacements]

下面的例子创建了 RAID1 逻辑卷,然后替换那个卷中的一个设备。

#lvcreate --type raid1 -m 2 -L 1G -n my_lv my_vgLogical volume "my_lv" created #lvs -a -o name,copy_percent,devices my_vgLV Copy% Devices my_lv 100.00 my_lv_rimage_0(0),my_lv_rimage_1(0),my_lv_rimage_2(0) [my_lv_rimage_0] /dev/sdb1(1) [my_lv_rimage_1] /dev/sdb2(1) [my_lv_rimage_2] /dev/sdc1(1) [my_lv_rmeta_0] /dev/sdb1(0) [my_lv_rmeta_1] /dev/sdb2(0) [my_lv_rmeta_2] /dev/sdc1(0) #lvconvert --replace /dev/sdb2 my_vg/my_lv#lvs -a -o name,copy_percent,devices my_vgLV Copy% Devices my_lv 37.50 my_lv_rimage_0(0),my_lv_rimage_1(0),my_lv_rimage_2(0) [my_lv_rimage_0] /dev/sdb1(1) [my_lv_rimage_1] /dev/sdc2(1) [my_lv_rimage_2] /dev/sdc1(1) [my_lv_rmeta_0] /dev/sdb1(0) [my_lv_rmeta_1] /dev/sdc2(0) [my_lv_rmeta_2] /dev/sdc1(0)

下面的例子创建了 RAID1 逻辑卷,然后替换那个卷中的一个设备,指定要用来替换哪些物理卷。

#lvcreate --type raid1 -m 1 -L 100 -n my_lv my_vgLogical volume "my_lv" created #lvs -a -o name,copy_percent,devices my_vgLV Copy% Devices my_lv 100.00 my_lv_rimage_0(0),my_lv_rimage_1(0) [my_lv_rimage_0] /dev/sda1(1) [my_lv_rimage_1] /dev/sdb1(1) [my_lv_rmeta_0] /dev/sda1(0) [my_lv_rmeta_1] /dev/sdb1(0) #pvsPV VG Fmt Attr PSize PFree /dev/sda1 my_vg lvm2 a-- 1020.00m 916.00m /dev/sdb1 my_vg lvm2 a-- 1020.00m 916.00m /dev/sdc1 my_vg lvm2 a-- 1020.00m 1020.00m /dev/sdd1 my_vg lvm2 a-- 1020.00m 1020.00m #lvconvert --replace /dev/sdb1 my_vg/my_lv /dev/sdd1#lvs -a -o name,copy_percent,devices my_vgLV Copy% Devices my_lv 28.00 my_lv_rimage_0(0),my_lv_rimage_1(0) [my_lv_rimage_0] /dev/sda1(1) [my_lv_rimage_1] /dev/sdd1(1) [my_lv_rmeta_0] /dev/sda1(0) [my_lv_rmeta_1] /dev/sdd1(0)

您可以通过一次指定多个

replace 参数来替换多个 RAID 设备,如下例所示。

#lvcreate --type raid1 -m 2 -L 100 -n my_lv my_vgLogical volume "my_lv" created #lvs -a -o name,copy_percent,devices my_vgLV Copy% Devices my_lv 100.00 my_lv_rimage_0(0),my_lv_rimage_1(0),my_lv_rimage_2(0) [my_lv_rimage_0] /dev/sda1(1) [my_lv_rimage_1] /dev/sdb1(1) [my_lv_rimage_2] /dev/sdc1(1) [my_lv_rmeta_0] /dev/sda1(0) [my_lv_rmeta_1] /dev/sdb1(0) [my_lv_rmeta_2] /dev/sdc1(0) #lvconvert --replace /dev/sdb1 --replace /dev/sdc1 my_vg/my_lv#lvs -a -o name,copy_percent,devices my_vgLV Copy% Devices my_lv 60.00 my_lv_rimage_0(0),my_lv_rimage_1(0),my_lv_rimage_2(0) [my_lv_rimage_0] /dev/sda1(1) [my_lv_rimage_1] /dev/sdd1(1) [my_lv_rimage_2] /dev/sde1(1) [my_lv_rmeta_0] /dev/sda1(0) [my_lv_rmeta_1] /dev/sdd1(0) [my_lv_rmeta_2] /dev/sde1(0)

注意

当您使用 lvconvert --replace 命令指定替换驱动器时,从阵列中已使用的驱动器上的额外空间分配替换驱动器。例如,

lv_rimage_0 和 lv_rimage_1 不应位于同一物理卷上。

4.4.3.11. 清理 RAID 逻辑卷

LVM 提供对 RAID 逻辑卷的清理支持。RAID 清理是读取阵列中的所有数据和奇偶校验块的过程,并检查它们是否是分配的。

您可以使用 lvchange 命令的

--syncaction 选项启动 RAID 清理操作。您可以指定 check 或 repair 操作。check 操作会接管阵列,并记录阵列中的差异数,但不会修复它们。repair 操作会更正发现的差异。

清理 RAID 逻辑卷的命令格式如下:

lvchange --syncaction {check|repair} vg/raid_lv注意

lvchange --syncaction repair vg/raid_lv 操作不执行与 lvconvert --repair vg/raid_lv 操作相同的功能。lvchange --syncaction repair 操作会在阵列中启动后台同步操作,而 lvconvert --repair 操作旨在修复/替换镜像或 RAID 逻辑卷中失败的设备。

支持新的 RAID 清理操作,lvs 命令现在支持两个新的可打印字段:

raid_sync_action 和 raid_mismatch_count。默认情况下不打印这些字段。要显示您使用 lvs 的 -o 参数指定的这些字段,如下所示:

lvs -o +raid_sync_action,raid_mismatch_count vg/lv

raid_sync_action 字段显示当前 raid 卷执行的同步操作。可以是以下值之一:

idle: 所有同步操作都完成(什么都不做)resync:初始化阵列或在机器失败后恢复恢复:替换阵列中的设备检查:查找阵列不一致repair:查找并修复不一致

raid_mismatch_count 字段显示 check 操作过程中发现的差异数。

lvs 命令的

Cpy%Sync 字段现在打印任何 raid_sync_action 操作的进度,包括 check 和 repair。

lvs 命令的输出的

lv_attr 字段现在提供额外的指示器,支持 RAID 清理操作。这个字段中的第 9 位显示逻辑卷的健康状况,它现在支持以下指示器。

- (m)不匹配表示 RAID 逻辑卷中存在差异。这个字符在清理操作侦测到部分 RAID 不一致时就会显示。

- (r)刷新表示 RAID 阵列中的设备存在故障,且内核将其视为失败,即使 LVM 可以读取该设备标签,并认为该设备正常。应(r)刷新逻辑卷来通知内核设备现在可用,或者如果怀疑设备有故障,应(r)替换它。

有关 lvs 命令的信息,请参考 第 4.8.2 节 “对象显示字段”。

当您执行 RAID 清理操作时,同步操作所需的后台 I/O 可以对 LVM 设备分离其他 I/O 操作,如卷组元数据更新。

您可以使用 lvchange 命令的

--minrecoveryrate 和 --maxrecoveryrate 选项设置这些操作的最小和最大 I/O 速率来控制执行 sync 操作的速率。如下所示指定这些选项。

--maxrecoveryrate Rate[bBsSkKmMgG]为 RAID 逻辑卷设置最大恢复率,使其不会阻断其他小的 I/O 操作。Rate 被指定为阵列中每个设备的每秒数量。如果没有给出后缀,则会假定为 kiB/sec/device。将恢复率设置为 0 表示它将不被绑定。--minrecoveryrate Rate[bBsSkKmMgG]为 RAID 逻辑卷设置最小恢复率,以确保sync操作的 I/O 达到最小吞吐量,即使存在大量 I/O。Rate 被指定为阵列中每个设备的每秒数量。如果没有给出后缀,则会假定为 kiB/sec/device。

4.4.3.12. RAID 接管(Red Hat Enterprise Linux 7.4 及更新的版本)

LVM 支持 Raid 接管,这意味着将 RAID 逻辑卷从一个 RAID 级别转换成另一个 RAID 级别(比如从 RAID 5 到 RAID 6)。更改 RAID 级别通常是为了增加或降低对设备故障的恢复能力或重新条带化逻辑卷。您可以对 RAID 接管使用 lvconvert 。有关 RAID 接管的信息,以及使用 lvconvert 转换 RAID 逻辑卷的示例,请参阅 lvmraid(7)手册页。

4.4.3.13. 重塑 RAID 逻辑卷(Red Hat Enterprise Linux 7.4 及更新版本)

RAID 重塑 意味着更改 RAID 逻辑卷的属性,而同时保持相同的 RAID 级别。您可以修改的一些属性包括 RAID 布局、条带大小和条带数目。有关 RAID 重塑和使用 lvconvert 命令重塑 RAID 逻辑卷的示例,请参考 lvmraid(7)手册页。

4.4.3.14. 对 RAID1 逻辑卷控制 I/O 操作

您可以使用 lvchange 命令的

--writemostly 和 --writebehind 参数控制 RAID1 逻辑卷中设备的 I/O 操作。使用这些参数的格式如下。

--[raid]writemostly PhysicalVolume[:{t|y|n}]将 RAID1 逻辑卷中的设备标记为write-mostly。除非需要,避免对这些驱动器的所有读取。设置此参数会使驱动器中的 I/O 操作数量保持最小。默认情况下,对于逻辑卷中指定的物理卷,write-mostly属性被设为 yes。通过将:n附加到物理卷或者通过指定:t来切换值,可以删除write-mostly标志。在单个命令中可以多次指定--writemostly参数,从而可以一次为逻辑卷中的所有物理卷切换 write-mostly 属性。--[raid]writebehind IOCount指定允许对标记为write-mostly的 RAID1 逻辑卷中设备的突出写的最大数。超过这个值后,写入就变为同步行为,在阵列指示写操作完成前,所有的写操作都需要已完成。将值设为零可清除首选项,并允许系统任意选择数值。

4.4.3.15. 更改 RAID 逻辑卷上的区域大小(Red Hat Enterprise Linux 7.4 及更新版本)

当您创建 RAID 逻辑卷时,逻辑卷的区域大小将是

/etc/lvm/lvm.conf 文件中 raid_region_size 参数的值。您可以使用 lvcreate 命令的 -R 选项来覆盖此默认值。

创建 RAID 逻辑卷后,您可以使用 lvconvert 命令的

-R 选项更改卷的区域大小。以下示例将逻辑卷 vg/raidlv 的区域大小改为 4096K。必须同步 RAID 卷以便更改区域大小。

#lvconvert -R 4096K vg/raid1Do you really want to change the region_size 512.00 KiB of LV vg/raid1 to 4.00 MiB? [y/n]:yChanged region size on RAID LV vg/raid1 to 4.00 MiB.

4.4.4. 创建镜像卷

对于 Red Hat Enterprise Linux 7.0 版本,LVM 支持 RAID 1/4/5/6/10,如 第 4.4.3 节 “RAID 逻辑卷” 中所述。RAID 逻辑卷不是集群感知的。虽然可以在一台机器上单独创建和激活 RAID 逻辑卷,但不能在多个机器上同时激活它们。如果需要非独占镜像卷,您必须创建带有

mirror 段类型的卷,如本节所述。

注意

有关将片段类型为

mirror 的现有 LVM 设备转换为 RAID1 LVM 设备的详情,请参考 第 4.4.3.4 节 “将镜像的 LVM 设备转换为 RAID1 设备”。

注意

在集群中创建镜像 LVM 逻辑卷需要与在单个节点上创建片段类型为

mirror 的镜像 LVM 逻辑卷的命令和流程相同。但是,为了在集群中创建镜像 LVM 卷,集群和集群镜像基础架构必须正在运行,集群必须是 quorate,且 lvm.conf 文件中的锁定类型必须正确设置以启用集群锁定。有关在集群中创建镜像卷的示例,请参阅 第 5.5 节 “在集群中创建镜像 LVM 逻辑卷”。

尝试从集群中的多个节点连续运行多个 LVM 镜像创建和转换命令,快速成功转换可能会导致这些命令的积压。这可能会导致一些请求的操作超时,因此会失败。为了避免这个问题,建议从集群的一个节点执行集群镜像创建命令。

当您创建镜像卷时,您可以使用 lvcreate 命令的

-m 参数指定要制作的数据副本数。指定 -m1 会创建一个镜像,它生成文件系统的两个副本:线性逻辑卷加上一个副本。同样,指定 -m2 会创建两个镜像,生成文件系统的三个副本。

以下命令创建一个具有单个镜像的镜像逻辑卷。卷大小为 50GB,名为

mirrorlv,它从卷组 vg0 中分离出来:

# lvcreate --type mirror -L 50G -m 1 -n mirrorlv vg0

LVM 镜像将被复制的设备划分成区域,默认大小为 512KB。您可以使用 lvcreate 命令的

-R 参数来指定区域大小(以 MB 为单位)。您还可以通过编辑 lvm.conf 文件中的 mirror_region_size 设置来更改默认区域大小。

注意

由于集群基础架构的限制,无法使用默认大小为 512KB 的区域创建大于 1.5TB 的集群镜像。需要更大镜像的用户应将区域大小从默认值增加到更大。增加区域大小失败将导致 LVM 创建挂起,并可能会挂起其他 LVM 命令。

作为指定大于 1.5TB 的镜像的区域大小的通用指导,您可能需要以 TB 为单位的镜像大小,并将该数量舍入到下一个 2 的电源,将这个数字用作 lvcreate 命令的

-R 参数。例如,如果您的镜像大小为 1.5TB,您可以指定 -R 2。如果您的镜像大小为 3TB,您可以指定 -R 4。对于镜像大小为 5TB,您可以指定 -R 8。

以下命令创建了一个区域大小为 2MB 的镜像逻辑卷:

# lvcreate --type mirror -m 1 -L 2T -R 2 -n mirror vol_group

创建镜像后,镜像区域会同步。对于大型镜像组件,同步过程可能需要很长时间。当您创建一个不需要恢复的新镜像时,您可以指定

--nosync 参数来指示不需要从第一个设备进行初始同步。

LVM 维护一个小日志,它用于跟踪哪些区域与镜像或镜像处于同步。默认情况下,此日志保存在磁盘上,它会在重启后保留,并确保每次机器重启或崩溃时不需要重新同步镜像。您可以使用

--mirrorlog core 参数指定此日志保存在内存中。这消除了需要额外的日志设备,但它要求每次重启时重新同步整个镜像。

以下命令从卷组

bigvg 中创建镜像逻辑卷。逻辑卷名为 ondiskmirvol,只有一个镜像。卷大小为 12MB,将镜像日志保留在内存中。

# lvcreate --type mirror -L 12MB -m 1 --mirrorlog core -n ondiskmirvol bigvg

Logical volume "ondiskmirvol" created

镜像日志创建在与创建任何镜像 leg 所在设备不同的设备上。但是,可以使用 vgcreate 命令的

--alloc anywhere 参数在与镜像 leg 相同的设备上创建镜像日志。这可能会降低性能,但允许您创建镜像,即使您只有两个底层设备。

以下命令创建一个具有单个镜像的镜像逻辑卷,镜像日志与任一镜像 leg 在同一设备上。在这个示例中,卷组

vg0 只包含两个设备。该命令在 vg0 卷组中创建一个名为 mirrorlv 的 500 MB 卷。

# lvcreate --type mirror -L 500M -m 1 -n mirrorlv -alloc anywhere vg0注意

有了集群镜像,镜像日志管理完全由当前具有最低集群 ID 的集群节点来负责。因此,当保存集群镜像日志的设备在集群子集中不可用时,集群镜像可以继续操作,而不受任何影响,只要具有最低 ID 的集群节点保留对镜像日志的访问。由于镜像未受到干扰,因此不会发出任何自动纠正操作(修复)。当最低 ID 的集群节点失去对镜像日志的访问时,自动操作将启动(不管是否可从其他节点访问日志)。

要创建自我镜像的镜像日志,您可以指定

--mirrorlog 镜像 参数。以下命令从卷组 bigvg 中创建镜像逻辑卷。逻辑卷名为 twologvol,它只有一个镜像。卷大小为 12MB,镜像日志是镜像的,每个日志保存在不同的设备上。

# lvcreate --type mirror -L 12MB -m 1 --mirrorlog mirrored -n twologvol bigvg

Logical volume "twologvol" created

与标准镜像日志一样,可以使用 vgcreate 命令的

--alloc anywhere 参数在与镜像 leg 相同的设备上创建冗余镜像日志。这可能会降低性能,但是它允许您创建冗余镜像日志,即使您没有足够的底层设备来使每个日志保留在与镜像 leg 不同的设备上。

创建镜像后,镜像区域会同步。对于大型镜像组件,同步过程可能需要很长时间。当您创建一个不需要恢复的新镜像时,您可以指定

--nosync 参数来指示不需要从第一个设备进行初始同步。

您可以指定哪个设备用于镜像 leg 和日志,以及要使用设备的哪个扩展。要强制日志在特定的磁盘上,请在要放置它的磁盘上精确指定一个扩展。LVM 不需要遵守设备在命令行上列出的顺序。如果列出了任何物理卷,则其是要分配的唯一空间。列表中包含的任何已分配的物理区块都将被忽略。

下面的命令创建了一个具有单个镜像的镜像逻辑卷,以及没有镜像的单个日志。卷大小为 500 MB,名为

mirrorlv,它被从卷组 vg0 中分离出来。镜像的第一个 leg 位于设备 /dev/sda1 上,镜像的第二个 leg 位于设备 /dev/sdb1 上,镜像日志位于 /dev/sdc1 上。

# lvcreate --type mirror -L 500M -m 1 -n mirrorlv vg0 /dev/sda1 /dev/sdb1 /dev/sdc1

以下命令创建一个具有单个镜像的镜像逻辑卷。卷大小为 500 MB,名为

mirrorlv,它被从卷组 vg0 中分离出来。镜像的第一个 leg 位于设备 /dev/sda1 的第 0 个扩展上,镜像的第二个 leg 位于设备 /dev/sdb1 的扩展 0 到 499 上,镜像日志从设备 /dev/sdc1 的扩展 0 开始。这些是 1MB 扩展。如果已经分配了任何指定的扩展,它们将被忽略。

# lvcreate --type mirror -L 500M -m 1 -n mirrorlv vg0 /dev/sda1:0-499 /dev/sdb1:0-499 /dev/sdc1:0注意

您可以将条带和镜像合并在一个逻辑卷中。在创建逻辑卷的同时指定镜像数(

--mirrors X)和条带数(--stripes Y)会导致构成镜像设备的设备被条带化。

4.4.4.1. 镜像逻辑卷失败策略

您可以使用

lvm.conf 文件的 activation 部分中的 mirror_image_fault_policy 和 mirror_log_fault_policy 参数定义镜像逻辑卷在设备失败时的行为。当这些参数设为 remove 时,系统会尝试删除有问题的设备,并在没有它的情况下运行。当这些参数设为 allocate 时,系统会尝试删除有问题的设备,并尝试在新设备上分配空间以替换失败的设备。如果没有为替换分配适当的设备和空间,则此策略的行为与 remove 策略类似。

默认情况下,

mirror_log_fault_policy 参数设置为 allocate。对日志使用此策略很快,并保持通过崩溃和重启同步状态的能力。如果将此策略设置为 remove,当日志设备无法将镜像转换为使用内存中日志时;在这个实例中,镜像不会记住崩溃和重启时的同步状态,并且整个镜像将被重新同步。

默认情况下,

mirror_image_fault_policy 参数被设为 remove。有了这个策略,如果镜像失败,如果只有一个保留了好的副本,则镜像将转换为非镜像设备。将这个策略设置为 allocate 镜像需要镜像重新同步设备 ; 这是一个较慢的过程,但它会保留该设备的镜像特性。

注意

当 LVM 镜像出现设备故障时,会进行两阶段的恢复。第一个阶段涉及删除故障设备。这可能导致镜像缩小成一个线性设备。第二个阶段,如果

mirror_log_fault_policy 参数设置为 allocate,则尝试替换任何失败设备。但请注意,如果其他设备可用,则不能保证第二阶段会选择之前镜像使用的、不是故障的一部分的设备。

有关从 LVM 镜像故障中手动恢复的详情,请参考 第 6.2 节 “从 LVM 镜像故障中恢复”。

4.4.4.2. 分离镜像逻辑卷的冗余镜像

您可以分离镜像逻辑卷的冗余镜像来形成一个新的逻辑卷。要分离镜像,请使用 lvconvert 命令的

--splitmirrors 参数,指定要分离的冗余镜像数量。您必须使用命令的 --name 参数新分离的逻辑卷指定名称。

下面的命令从镜像逻辑卷

vg/lv 中分离出一个名为 copy 的新逻辑卷。新逻辑卷包含两个镜像 leg。在这个示例中,LVM 选择要分离哪个设备。

# lvconvert --splitmirrors 2 --name copy vg/lv

您可以指定要分离哪个设备。下面的命令从镜像逻辑卷

vg/lv 中分离出一个名为 copy 的新逻辑卷。新逻辑卷包含两个镜像 leg,它由设备 /dev/sdc1 和 /dev/sde1 组成。

# lvconvert --splitmirrors 2 --name copy vg/lv /dev/sd[ce]14.4.4.3. 修复镜像逻辑设备

您可以使用 lvconvert --repair 命令在磁盘失败后修复镜像。这会将镜像重新变回一致的状态。lvconvert --repair 命令是一个交互式命令,提示您指示是否希望系统尝试替换任何失败的设备。

- 要跳过提示并替换所有故障设备,请在命令行上指定

-y选项。 - 要跳过提示并不替换任何故障设备,请在命令行上指定

-f选项。 - 要跳过提示并仍然指明镜像镜像和镜像日志的不同替换策略,您可以指定

--use-policies参数,以使用由lvm.conf文件中的mirror_log_fault_policy和mirror_device_fault_policy参数指定的设备替换策略。

4.4.4.4. 更改镜像卷配置

您可以使用 lvconvert 命令增加或减少逻辑卷包含的镜像数。这允许您将逻辑卷从镜像卷转换为线性卷,或者从线性卷转换为镜像卷。您还可以使用这个命令重新配置现有逻辑卷的其他镜像参数,如

corelog。

当您将线性卷转换为镜像卷时,您在为现有卷创建镜像 leg。这意味着您的卷组必须包含镜像 leg 和镜像日志的设备和空间。

如果您丢失了镜像的 leg,LVM 会将卷转换为线性卷,以便您仍可以访问卷,而无需镜像冗余。替换 leg 后,使用 lvconvert 命令恢复镜像。此过程在 第 6.2 节 “从 LVM 镜像故障中恢复” 中提供。

以下命令将线性逻辑卷

vg00/lvol1 转换为镜像逻辑卷。

# lvconvert -m1 vg00/lvol1

以下命令将镜像逻辑卷

vg00/lvol1 转换为线性逻辑卷,删除镜像 leg。

# lvconvert -m0 vg00/lvol1

以下示例将额外的镜像 leg 添加到现有逻辑卷

vg00/lvol1 中。本例演示了 lvconvert 命令将卷更改为具有两个镜像 leg 的卷之前和之后卷的配置。

#lvs -a -o name,copy_percent,devices vg00LV Copy% Devices lvol1 100.00 lvol1_mimage_0(0),lvol1_mimage_1(0) [lvol1_mimage_0] /dev/sda1(0) [lvol1_mimage_1] /dev/sdb1(0) [lvol1_mlog] /dev/sdd1(0) #lvconvert -m 2 vg00/lvol1vg00/lvol1: Converted: 13.0% vg00/lvol1: Converted: 100.0% Logical volume lvol1 converted. #lvs -a -o name,copy_percent,devices vg00LV Copy% Devices lvol1 100.00 lvol1_mimage_0(0),lvol1_mimage_1(0),lvol1_mimage_2(0) [lvol1_mimage_0] /dev/sda1(0) [lvol1_mimage_1] /dev/sdb1(0) [lvol1_mimage_2] /dev/sdc1(0) [lvol1_mlog] /dev/sdd1(0)

4.4.5. 创建精简配置的逻辑卷

逻辑卷可以使用精简模式置备。这可让您创建大于可用扩展的逻辑卷。使用精简配置,您可以管理一个空闲空间的存储池,称为精简池,可在应用程序需要时将其分配给任意数量的设备。然后,当应用程序实际写入逻辑卷时,您可以创建可绑定到精简池的设备以便以后分配。可在需要时动态扩展精简池,以便有效分配存储空间。

注意

本节提供了您用来创建和增长精简配置逻辑卷的基本命令的概述。有关 LVM 精简配置的详情,以及使用带精简置备逻辑卷的 LVM 命令和工具的详情,请参考 lvmthin(7)手册页。

注意

不支持集群中跨节点的精简卷。精简池及其所有精简卷必须只在一个集群节点中单独激活。

要创建精简卷,请执行以下任务:

- 使用 vgcreate 命令创建卷组。

- 使用 lvcreate 命令创建精简池。

- 使用 lvcreate 命令在精简池中创建精简卷。

您可以使用 lvcreate 命令的

-T (或 --thin)选项来创建精简池或精简卷。您还可以使用 lvcreate 命令的 -T 选项,通过单个命令同时在该池中创建精简池和精简卷。

以下命令使用 lvcreate 命令的

-T 选项在卷组 vg001 中创建一个名为 mythinpool 的精简池,大小为 100M。请注意:由于您要创建物理空间池,您必须指定池的大小。lvcreate 命令的 -T 选项不使用参数;它会从命令指定的其他选项中推断要创建的设备类型。

#lvcreate -L 100M -T vg001/mythinpoolRounding up size to full physical extent 4.00 MiB Logical volume "mythinpool" created #lvsLV VG Attr LSize Pool Origin Data% Move Log Copy% Convert my mythinpool vg001 twi-a-tz 100.00m 0.00

以下命令使用 lvcreate 命令的

-T 选项在精简池 vg001/mythinpool 中创建一个名为 thinvolume 的精简卷。请注意:在这种情况下,您要指定虚拟大小,并且您要为容量大于包含它的卷指定虚拟大小。

#lvcreate -V 1G -T vg001/mythinpool -n thinvolumeLogical volume "thinvolume" created #lvsLV VG Attr LSize Pool Origin Data% Move Log Copy% Convert mythinpool vg001 twi-a-tz 100.00m 0.00 thinvolume vg001 Vwi-a-tz 1.00g mythinpool 0.00

以下命令使用 lvcreate 命令的

-T 选项通过为 lvcreate 命令指定大小和虚拟大小参数来在该池中创建精简池和精简卷。这个命令在卷组 vg001 中创建一个名为 mythinpool 的精简池,它还在该池中创建一个名为 thinvolume 的精简卷。

#lvcreate -L 100M -T vg001/mythinpool -V 1G -n thinvolumeRounding up size to full physical extent 4.00 MiB Logical volume "thinvolume" created #lvsLV VG Attr LSize Pool Origin Data% Move Log Copy% Convert mythinpool vg001 twi-a-tz 100.00m 0.00 thinvolume vg001 Vwi-a-tz 1.00g mythinpool 0.00

您还可以通过指定 lvcreate 命令的

--thinpool 参数来创建精简池。与 -T 选项不同,-- thinpool 参数需要一个参数,这是您要创建的精简池逻辑卷的名称。以下示例指定了 lvcreate 命令的 --thinpool 参数,来在卷组 vg001 中创建一个名为 mythinpool 的精简池,大小为 100M:

#lvcreate -L 100M --thinpool mythinpool vg001Rounding up size to full physical extent 4.00 MiB Logical volume "mythinpool" created #lvsLV VG Attr LSize Pool Origin Data% Move Log Copy% Convert mythinpool vg001 twi-a-tz 100.00m 0.00

对块大小使用以下标准:

- 较小的块大小需要更多元数据,并阻碍了性能,但它提供了更好的快照空间利用率。

- 大型块大小需要较少的元数据操作,但制作快照效率较低。

LVM2 使用以下方法计算块大小:

默认情况下,LVM 以 64KiB 块大小开始,并在精简池元数据设备的大小超过 128MiB 时增加其值,因此元数据大小会保持紧凑。这可能会导致一些大的块值,这对快照使用效率较低。在这种情况下,较小的块大小和较大的元数据大小是一个更好的选择。

如果卷数据的大小在 TiB 范围,使用 ~15.8GiB 元数据大小(这是最大支持的大小),并根据您的要求使用块大小。但是,如果您需要扩展这个卷数据的大小,且只有一个小的块大小,则无法增大元数据大小。

警告

红帽建议至少使用默认块大小。如果块太小,且您的卷空间不足用于元数据,则该卷将无法创建数据。监控逻辑卷,以确保它们在元数据卷完全变满之前扩展或创建更多的存储。确保建立了具有足够大块大小的精简池,这样就不会耗尽元数据的空间。

创建池时支持条带。以下命令在卷组

vg001 中创建一个名为 pool 的 100M 的精简池,其中有两个 64 kB 条带,块大小为 256 kB。它还创建一个 1T 精简卷 vg00/thin_lv。

# lvcreate -i 2 -I 64 -c 256 -L 100M -T vg00/pool -V 1T --name thin_lv

您可以使用 lvextend 命令扩展精简卷的大小。但是您无法缩小精简池的大小。

以下命令调整了一个已存在的精简池大小,其大小为 100M,这样就扩展为 100M。

#lvextend -L+100M vg001/mythinpoolExtending logical volume mythinpool to 200.00 MiB Logical volume mythinpool successfully resized #lvsLV VG Attr LSize Pool Origin Data% Move Log Copy% Convert mythinpool vg001 twi-a-tz 200.00m 0.00 thinvolume vg001 Vwi-a-tz 1.00g mythinpool 0.00

与其他类型的逻辑卷一样,您可以使用 lvrename 重命名卷,您可以使用 lvremove 删除卷,您可以使用 lvs 和 lvdisplay 命令显示卷的信息。

默认情况下,lvcreate 命令根据公式(Pool_LV_size / Pool_LV_chunk_size * 64)设置精简池元数据逻辑卷的大小。如果您有大量快照,或者您的精简池有小的块,并且预计以后精简池的大小会显著增长,您可能需要使用 lvcreate 命令的

--poolmetadatasize 参数增加精简池的元数据卷的默认值。精简池元数据逻辑卷支持的值在 2MiB 到 16GiB 之间。

您可以使用 lvconvert 命令的

--thinpool 参数将现有逻辑卷转换为精简池卷。当您将现有逻辑卷转换为精简池卷时,您必须将 lvconvert 的 --poolmetadata 参数与 --thinpool 参数一起使用,将现有逻辑卷转换为精简池卷的元数据卷。

注意

将逻辑卷转换成精简池卷或精简池元数据卷会破坏逻辑卷的内容,因为在这种情况下,lvconvert 不会保留设备的内容,而是覆盖其内容。

以下示例将卷组

vg001 中的现有逻辑卷 lv1 转换为精简池卷,并将卷组 vg001 中的现有逻辑卷 lv2 转换为那个精简池卷的元数据卷。

# lvconvert --thinpool vg001/lv1 --poolmetadata vg001/lv2

Converted vg001/lv1 to thin pool.

4.4.6. 创建快照卷

注意

LVM 支持精简配置的快照。有关创建精简配置快照卷的详情,请参考 第 4.4.7 节 “创建精简配置的快照卷”。

使用 lvcreate 命令的

-s 参数来创建快照卷。快照卷是可写的。

注意

不支持集群中跨节点的 LVM 快照。您不能在集群卷组中创建快照卷。但是,如果您需要在集群逻辑卷上创建一致的数据备份,您可以只激活该卷,然后创建快照。有关在一个节点上只激活逻辑卷的详情,请参考 第 4.7 节 “激活集群中单个节点上的逻辑卷”。

注意

镜像逻辑卷支持 LVM 快照。

RAID 逻辑卷支持快照。有关创建 RAID 逻辑卷的详情,请参考 第 4.4.3 节 “RAID 逻辑卷”。

LVM 不允许创建大于原始卷大小的快照卷,以及卷所需的元数据。如果您指定大于这个卷的快照卷,则系统会创建一个只根据原始卷大小所需的快照卷。

默认情况下,在正常激活命令中会跳过快照卷。有关控制快照卷的激活的详情,请参考 第 4.4.20 节 “控制逻辑卷激活”。

以下命令创建一个大小为 100 MB 的快照逻辑卷,其大小为

/dev/vg00/snap。这会创建一个名为 /dev/vg00/lvol1 的原始逻辑卷的快照。如果原始逻辑卷包含一个文件系统,您可以在任意目录中挂载快照逻辑卷,以便访问文件系统的内容,并在不断更新原始文件系统时进行备份。

# lvcreate --size 100M --snapshot --name snap /dev/vg00/lvol1

创建快照逻辑卷后,在 lvdisplay 命令中指定原始卷会产生输出,其中包含所有快照逻辑卷的列表及其状态(活跃或不活跃)。

以下示例显示了逻辑卷

/dev/new_vg/lvol0 的状态,其快照卷 /dev/new_vg/newvgsnap 已创建。

# lvdisplay /dev/new_vg/lvol0

--- Logical volume ---

LV Name /dev/new_vg/lvol0

VG Name new_vg

LV UUID LBy1Tz-sr23-OjsI-LT03-nHLC-y8XW-EhCl78

LV Write Access read/write

LV snapshot status source of

/dev/new_vg/newvgsnap1 [active]

LV Status available

# open 0

LV Size 52.00 MB

Current LE 13

Segments 1

Allocation inherit

Read ahead sectors 0

Block device 253:2

默认情况下,lvs 命令会显示原始卷以及正在使用的快照卷的百分比。以下示例显示了包含逻辑卷

/dev/new_vg/lvol0 的 lvs 命令的默认输出,其快照卷 /dev/new_vg/newvgsnap 已创建。

# lvs

LV VG Attr LSize Origin Snap% Move Log Copy%

lvol0 new_vg owi-a- 52.00M

newvgsnap1 new_vg swi-a- 8.00M lvol0 0.20

警告

因为快照会在原始卷更改时增加大小,因此使用 lvs 命令定期监控快照卷的百分比以确保其没有填满。使用了 100% 的快照会完全丢失,因为对原始卷中未更改的部分的写入无法在不破坏快照的情况下无法成功。

当快照已满时,除了快照本身无效外,所有在那个快照设备中挂载的文件系统都会被强制卸载,这避免了访问挂载点时出现的文件系统错误。另外,您可以在

lvm.conf 文件中指定 snapshot_autoextend_threshold 选项。这个选项允许在剩余的快照空间低于您设定的阈值时自动扩展快照。这个功能要求卷组中还有未被分配的空间。

LVM 不允许创建大于原始卷大小的快照卷,以及卷所需的元数据。同样,快照的自动扩展不会将快照卷的大小增加到超过计算的快照所需的最大值。一旦快照增长到足够大来覆盖原始数据后,便不会再监控它是否发生了自动扩展。

lvm.conf 文件本身中提供了有关设置 snapshot_autoextend_threshold 和 snapshot_autoextend_percent 的信息。有关 lvm.conf 文件的详情,请参考 附录 B, LVM 配置文件。

4.4.7. 创建精简配置的快照卷

Red Hat Enterprise Linux 支持精简配置的快照卷。有关精简快照卷的优点和限制的详情,请参考 第 2.3.6 节 “精简配置的快照卷”。

注意

本节概述您用来创建和增加精简置备快照卷的基本命令。有关 LVM 精简配置的详情,以及使用带精简置备逻辑卷的 LVM 命令和工具的详情,请参考 lvmthin(7)手册页。

重要

在创建精简快照卷时,您不用指定卷的大小。如果指定了 size 参数,则创建的快照不会是一个精简快照卷,也不会使用精简池来存储数据。例如,命令

lvcreate -s vg/thinvolume -L10M 不会创建精简快照,即使原始卷是精简卷。

可为精简配置的原始卷创建精简快照,也可针对不是精简置备的原始卷创建精简快照。

您可以使用 lvcreate 命令的

--name 选项为快照卷指定名称。以下命令创建一个精简配置的逻辑卷 vg001/thinvolume 的精简配置的快照卷,名为 mysnapshot1。

#lvcreate -s --name mysnapshot1 vg001/thinvolumeLogical volume "mysnapshot1" created #lvsLV VG Attr LSize Pool Origin Data% Move Log Copy% Convert mysnapshot1 vg001 Vwi-a-tz 1.00g mythinpool thinvolume 0.00 mythinpool vg001 twi-a-tz 100.00m 0.00 thinvolume vg001 Vwi-a-tz 1.00g mythinpool 0.00

注意

在使用精简配置时,存储管理员务必要监控存储池,并在其被完全占用时添加更多容量。有关扩展精简卷大小的详情,请参考 第 4.4.5 节 “创建精简配置的逻辑卷”

精简快照卷具有与其它精简卷相同的特征。您可以独立激活卷、扩展卷、重新命名卷、删除卷、甚至快照卷。

默认情况下,在正常激活命令中会跳过快照卷。有关控制快照卷的激活的详情,请参考 第 4.4.20 节 “控制逻辑卷激活”。

您还可以为非置备的逻辑卷创建精简配置的快照。因为非精简配置的逻辑卷不包含在精简池中,所以它被称为 外部原始卷。外部原始卷可以被很多精简置备的快照卷使用和共享,即使在不同的精简池中也是如此。在创建精简置备快照时,外部原始源必须不活跃且只读。

要为外部原始卷创建一个精简配置的快照,您必须指定

--thinpool 选项。以下命令创建一个只读不活跃卷 origin_volume 的精简快照卷。精简快照卷名为 mythinsnap。然后,逻辑卷 origin_volume 在卷组 vg001 中成为精简快照卷 mythinsnap 的精简外部来源,它将使用现有的精简池 vg001/pool。因为原始卷必须与快照卷位于同一个卷组中,所以您在指定原始逻辑卷时不需要指定卷组。

# lvcreate -s --thinpool vg001/pool origin_volume --name mythinsnap

您可以创建第一个快照卷的第二个精简置备快照卷,如下例所示。

# lvcreate -s vg001/mythinsnap --name my2ndthinsnap

从 Red Hat Enterprise Linux 7.2 开始,您可以通过指定 lvs 命令的

lv_ancestors 和 lv_descendants 报告字段来显示精简快照逻辑卷的所有上级和后代的列表。

在以下示例中:

stack1是卷组vg001中的原始卷。stack2是stack1的快照stack3是stack2的快照stack4是stack3的快照

另外:

stack5也是stack2的快照stack6是stack5的快照

$ lvs -o name,lv_ancestors,lv_descendants vg001

LV Ancestors Descendants

stack1 stack2,stack3,stack4,stack5,stack6

stack2 stack1 stack3,stack4,stack5,stack6

stack3 stack2,stack1 stack4

stack4 stack3,stack2,stack1

stack5 stack2,stack1 stack6

stack6 stack5,stack2,stack1

pool

注意

lv_ancestors 和 lv_descendants 字段显示现有的依赖项,但不跟踪删除的条目,如果从链中删除了条目,则可能会破坏依赖项链。例如,如果您从这个示例配置中删除逻辑卷 stack3,如下所示:

$ lvs -o name,lv_ancestors,lv_descendants vg001

LV Ancestors Descendants

stack1 stack2,stack5,stack6

stack2 stack1 stack5,stack6

stack4

stack5 stack2,stack1 stack6

stack6 stack5,stack2,stack1

pool

从 Red Hat Enterprise Linux 7.3 开始,您可以将您的系统配置为跟踪和显示已删除的逻辑卷,您可以通过指定

lv_ancestors_full 和 lv_descendants_full 字段来显示包括这些卷的完整依赖关系链。有关跟踪、显示和删除历史逻辑卷的详情,请参考 第 4.4.21 节 “跟踪并显示历史逻辑卷(Red Hat Enterprise Linux 7.3 及更高版本)”。

4.4.8. 创建 LVM 缓存逻辑卷

自 Red Hat Enterprise Linux 7.1 发行版本中,LVM 提供对 LVM 缓存逻辑卷的全面支持。缓存逻辑卷使用由快速块设备(比如 SSD 驱动器)组成的小逻辑卷,通过存储在较小的、更快的逻辑卷中存储常用的块来提高更大的、较慢的逻辑卷性能。

LVM 缓存使用以下 LVM 逻辑卷类型。所有这些相关的逻辑卷必须位于同一卷组中。

- 原始逻辑卷 - 大、慢的逻辑卷

- 缓存池逻辑卷 - 小、快的逻辑卷,由两个设备组成:缓存数据逻辑卷和缓存元数据逻辑卷

- 缓存数据逻辑卷 - 包含缓存池逻辑卷的数据块的逻辑卷

- 缓存元数据逻辑卷 - 包含缓存池逻辑卷的元数据的逻辑卷,其保存指定数据块存储位置(例如,在原始逻辑卷上或在缓存数据逻辑卷上)的记帐信息。

- 缓存逻辑卷 - 包含原始逻辑卷和缓存池逻辑卷的逻辑卷。这是封装了各种缓存卷组件的最终可用设备。

下面的流程创建了一个 LVM 缓存逻辑卷。

- 创建一个包含慢物理卷和快物理卷的卷组。在本例中:

/dev/sde1是一个较慢的设备,/dev/sdf1是一个快速设备,两个设备都包含在卷组VG中。#

pvcreate /dev/sde1#pvcreate /dev/sdf1#vgcreate VG /dev/sde1 /dev/sdf1 - 创建原始卷。这个示例创建一个名为

lv的原始卷,大小为 10GB,它由/dev/sde1(较慢的物理卷)组成。#

lvcreate -L 10G -n lv VG /dev/sde1 - 创建缓存池逻辑卷。这个示例在快速设备

/dev/sdf1上创建了一个名为cpool的缓存池逻辑卷,它是卷组VG的一部分。此命令创建的缓存池逻辑卷由隐藏的缓存数据逻辑卷cpool_cdata和隐藏的缓存元数据逻辑卷cpool_cmeta组成。#

lvcreate --type cache-pool -L 5G -n cpool VG /dev/sdf1Using default stripesize 64.00 KiB. Logical volume "cpool" created. #lvs -a -o name,size,attr,devices VGLV LSize Attr Devices [cpool] 5.00g Cwi---C--- cpool_cdata(0) [cpool_cdata] 5.00g Cwi-ao---- /dev/sdf1(4) [cpool_cmeta] 8.00m ewi-ao---- /dev/sdf1(2)对于更复杂的配置,您可能需要单独创建缓存数据和缓存元数据逻辑卷,然后将卷合并成一个缓存池逻辑卷中。有关此过程的详情,请参考 lvmcache(7)手册页。 - 通过将缓存池逻辑卷链接到原始逻辑卷来创建缓存逻辑卷。生成的用户可访问的缓存逻辑卷采用原始逻辑卷的名称。原始卷成为一个隐藏逻辑卷,

_corig附加到原始名称。请注意,此转换可以实时完成,但您必须首先执行了备份。#

lvconvert --type cache --cachepool cpool VG/lvLogical volume cpool is now cached. #lvs -a -o name,size,attr,devices vgLV LSize Attr Devices [cpool] 5.00g Cwi---C--- cpool_cdata(0) [cpool_cdata] 5.00g Cwi-ao---- /dev/sdf1(4) [cpool_cmeta] 8.00m ewi-ao---- /dev/sdf1(2) lv 10.00g Cwi-a-C--- lv_corig(0) [lv_corig] 10.00g owi-aoC--- /dev/sde1(0) [lvol0_pmspare] 8.00m ewi------- /dev/sdf1(0) - 另外,从 Red Hat Enterprise Linux 7.2 开始,您可以将缓存逻辑卷转换为精简池逻辑卷。请注意,任何从池中创建的精简逻辑卷都将共享缓存。以下命令使用快速设备

/dev/sdf1来分配精简池元数据(lv_tmeta)。这是缓存池卷使用的相同设备,这意味着精简池元数据卷与缓存数据逻辑卷cpool_cdata和缓存元数据逻辑卷cpool_cmeta共享该设备。#

lvconvert --type thin-pool VG/lv /dev/sdf1WARNING: Converting logical volume VG/lv to thin pool's data volume with metadata wiping. THIS WILL DESTROY CONTENT OF LOGICAL VOLUME (filesystem etc.) Do you really want to convert VG/lv? [y/n]:yConverted VG/lv to thin pool. #lvs -a -o name,size,attr,devices vgLV LSize Attr Devices [cpool] 5.00g Cwi---C--- cpool_cdata(0) [cpool_cdata] 5.00g Cwi-ao---- /dev/sdf1(4) [cpool_cmeta] 8.00m ewi-ao---- /dev/sdf1(2) lv 10.00g twi-a-tz-- lv_tdata(0) [lv_tdata] 10.00g Cwi-aoC--- lv_tdata_corig(0) [lv_tdata_corig] 10.00g owi-aoC--- /dev/sde1(0) [lv_tmeta] 12.00m ewi-ao---- /dev/sdf1(1284) [lvol0_pmspare] 12.00m ewi------- /dev/sdf1(0) [lvol0_pmspare] 12.00m ewi------- /dev/sdf1(1287)

有关 LVM 缓存卷的详情,包括额外的管理示例,请参阅 lvmcache(7)手册页。

有关创建精简配置的逻辑卷的详情,请参考 第 4.4.5 节 “创建精简配置的逻辑卷”。

4.4.9. 合并快照卷

您可以使用 lvconvert 命令的

--merge 选项将快照合并到其原始卷中。如果原始卷和快照卷都没有打开,则合并将立即开始。否则会在激活原始卷或快照卷并全部处于关闭状态时第一次执行合并。将快照合并到无法关闭的原始卷(如 root 文件系统)的过程中会延迟到下一次原始卷被激活时。当合并开始后,得到的逻辑卷将具有原始卷的名称、副号码和 UUID。在合并过程中,对原始卷的读取和写入将会被指向要合并的快照。当合并完成后,会删除合并的快照。

以下命令将快照卷

vg00/lvol1_snap 合并到其原始卷中。

# lvconvert --merge vg00/lvol1_snap

您可以在命令行中指定多个快照,或者您可以使用 LVM 对象标签指定要合并到其各自原始卷的快照。在以下示例中,逻辑卷

vg00/lvol1、vg00/lvol2 和 vg00/lvol3 都标记为标签 @some_tag。以下命令按顺序合并所有三个卷的快照逻辑卷: vg00/lvol1,然后 vg00/lvol2,然后 vg00/lvol3。如果使用了 --background 选项,则所有快照逻辑卷合并都将并行开始。

# lvconvert --merge @some_tag4.4.10. 持久的设备号

在载入模块的时候会自动分配主设备号码和副设备号码。如果总是使用相同的设备(主和副)号码激活块设备,有些应用程序效果最好。您可以使用以下参数通过 lvcreate 和 lvchange 命令来指定这些参数:

--persistent y --major major --minor minor

使用大的副号以确定还没有动态分配给另一个设备。

如果您要使用 NFS 导出文件系统,请在导出文件中指定

fsid 参数,这可以避免在 LVM 中设置持久的设备号。

4.4.11. 更改逻辑卷组的参数

要更改逻辑卷的参数,请使用 lvchange 命令。有关您可以更改的参数列表,请参阅 lvchange(8)手册页。

以下命令将卷组

vg00 中卷 lvol1 的权限更改为只读。

# lvchange -pr vg00/lvol14.4.12. 重命名逻辑卷

要重命名现有逻辑卷,请使用 lvrename 命令。

下面的任意一个命令将卷组

vg02 中的逻辑卷 lvold 重命名为 lvnew。

# lvrename /dev/vg02/lvold /dev/vg02/lvnew

# lvrename vg02 lvold lvnew

重命名根逻辑卷需要额外的重新配置。有关重命名根卷的详情,请参考 如何在 Red Hat Enterprise Linux 中重命名根卷组或者逻辑卷。

有关激活集群中单个节点上的逻辑卷的详情,请参考 第 4.7 节 “激活集群中单个节点上的逻辑卷”。

4.4.13. 删除逻辑卷

要删除不活跃的逻辑卷,请使用 lvremove 命令。如果逻辑卷当前已被挂载,请在删除卷前先卸载它。另外,在集群环境中,在删除逻辑卷之前,您必须先停用它。

以下命令从卷组

testvg 中删除逻辑卷 /dev/testvg/testlv。请注意,在这种情况下,逻辑卷还没有被停用。

#lvremove /dev/testvg/testlvDo you really want to remove active logical volume "testlv"? [y/n]:yLogical volume "testlv" successfully removed

在使用 lvchange -an 命令删除逻辑卷前,您可以明确取消激活它,在这种情况下,您不会看到验证是否要删除活跃逻辑卷的提示。

4.4.14. 显示逻辑卷

您可以使用三个命令来显示 LVM 逻辑卷的属性: lvs、lvdisplay 和 lvscan。

lvdisplay 命令以固定格式显示逻辑卷属性(如大小、布局和映射)。

以下命令显示

vg00 中 lvol2 的属性。如果已为这个原始逻辑卷创建了快照逻辑卷,这个命令会显示所有快照逻辑卷及其状态(活跃或不活跃)的列表。

# lvdisplay -v /dev/vg00/lvol2

lvscan 命令扫描系统中所有逻辑卷并列出它们,如下例所示。

# lvscan

ACTIVE '/dev/vg0/gfslv' [1.46 GB] inherit

4.4.15. 增大逻辑卷

要增大逻辑卷的大小,请使用 lvextend 命令。

当扩展逻辑卷时,可以指定您想要增大的量,或者指定扩展它需要达到的大小。

以下命令将逻辑卷

/dev/myvg/homevol 扩展到 12GB。

# lvextend -L12G /dev/myvg/homevol

lvextend -- extending logical volume "/dev/myvg/homevol" to 12 GB

lvextend -- doing automatic backup of volume group "myvg"

lvextend -- logical volume "/dev/myvg/homevol" successfully extended

以下命令在逻辑卷

/dev/myvg/homevol 中添加了 1GB。

# lvextend -L+1G /dev/myvg/homevol

lvextend -- extending logical volume "/dev/myvg/homevol" to 13 GB

lvextend -- doing automatic backup of volume group "myvg"

lvextend -- logical volume "/dev/myvg/homevol" successfully extended

与 lvcreate 命令一样,您可以使用 lvextend 命令的

-l 参数来指定扩展数目,从而增大逻辑卷的大小。您还可以使用此参数指定卷组的比例或者卷组中剩余空间的比例。以下命令将名为 testlv 的逻辑卷扩展到卷组 myvg 中所有未分配的空间。

# lvextend -l +100%FREE /dev/myvg/testlv

Extending logical volume testlv to 68.59 GB

Logical volume testlv successfully resized

当扩展逻辑卷后,有必要增大文件系统的大小以匹配文件系统。

默认情况下,大多数重新定义文件系统大小的工具都会将文件系统的大小增加到基本逻辑卷的大小,这样您就不必考虑为两个命令指定相同的容量。

4.4.16. 缩小逻辑卷