16.4. 安装程序置备的安装后配置

成功部署安装程序置备的集群后,请考虑以下安装后流程。

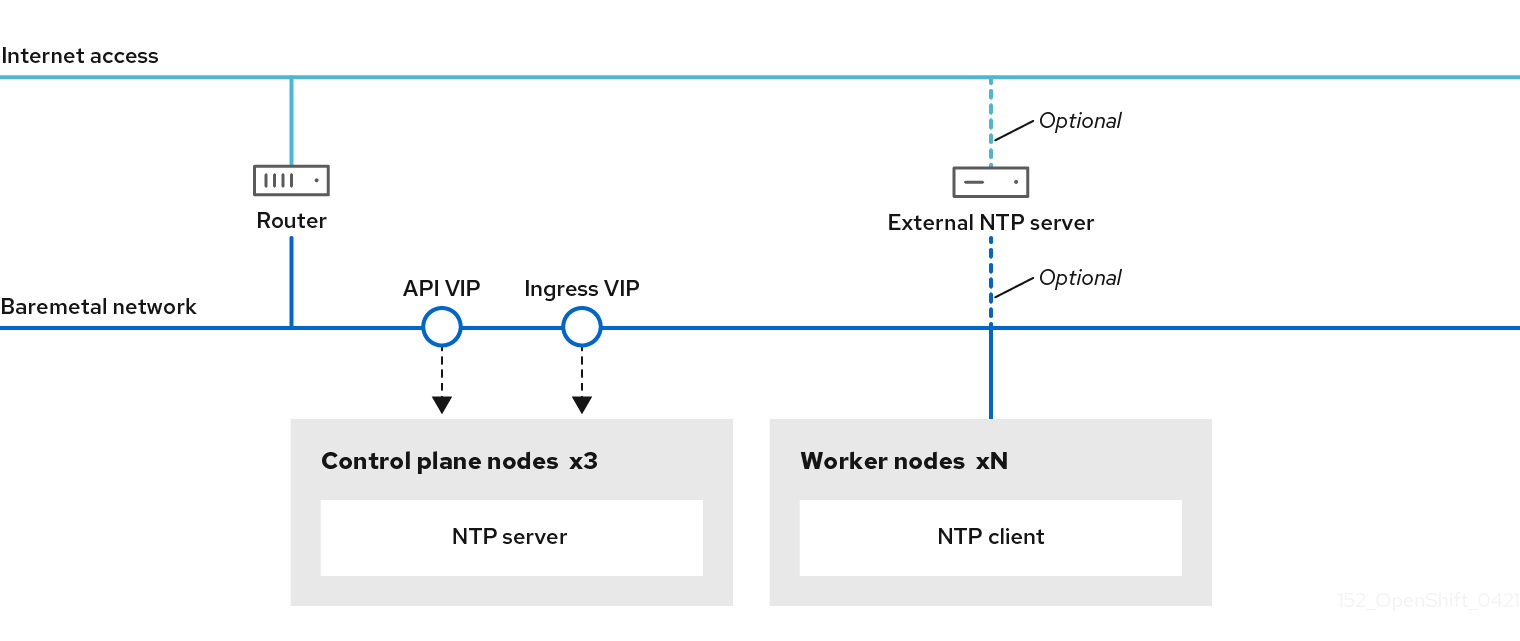

16.4.1. 可选:为断开连接的集群配置 NTP

OpenShift Container Platform 在集群节点上安装 chrony 网络时间协议(NTP)服务。使用以下步骤在 control plane 节点上配置 NTP 服务器,并将 worker 节点配置为成功部署后,将 worker 节点配置为 control plane 节点的 NTP 客户端。

OpenShift Container Platform 节点必须在日期和时间上达成一致才能正确运行。当 worker 节点从 control plane 节点上的 NTP 服务器检索日期和时间时,它会启用未连接到可路由网络的集群的安装和操作,因此无法访问更高的 stratum NTP 服务器。

流程

为 control plane 节点创建一个 Butane 配置

99-master-chrony-conf-override.bu,包括chrony.conf文件的内容。注意如需有关 Butane 的信息,请参阅"使用 Butane 创建机器配置"。

但ane 配置示例

variant: openshift version: 4.12.0 metadata: name: 99-master-chrony-conf-override labels: machineconfiguration.openshift.io/role: master storage: files: - path: /etc/chrony.conf mode: 0644 overwrite: true contents: inline: | # Use public servers from the pool.ntp.org project. # Please consider joining the pool (https://www.pool.ntp.org/join.html). # The Machine Config Operator manages this file server openshift-master-0.<cluster-name>.<domain> iburst 1 server openshift-master-1.<cluster-name>.<domain> iburst server openshift-master-2.<cluster-name>.<domain> iburst stratumweight 0 driftfile /var/lib/chrony/drift rtcsync makestep 10 3 bindcmdaddress 127.0.0.1 bindcmdaddress ::1 keyfile /etc/chrony.keys commandkey 1 generatecommandkey noclientlog logchange 0.5 logdir /var/log/chrony # Configure the control plane nodes to serve as local NTP servers # for all worker nodes, even if they are not in sync with an # upstream NTP server. # Allow NTP client access from the local network. allow all # Serve time even if not synchronized to a time source. local stratum 3 orphan- 1

- 您必须将

<cluster-name>替换为集群名称,并将<domain>替换为完全限定域名。

使用 Butane 生成

MachineConfig对象文件99-master-chrony-conf-override.yaml,其中包含要发送到 control plane 节点的配置:$ butane 99-master-chrony-conf-override.bu -o 99-master-chrony-conf-override.yaml

为引用 control plane 节点上的 NTP 服务器的 worker 节点创建 Butane 配置

99-worker-chrony-conf-override.bu,包括chrony.conf文件的内容。但ane 配置示例

variant: openshift version: 4.12.0 metadata: name: 99-worker-chrony-conf-override labels: machineconfiguration.openshift.io/role: worker storage: files: - path: /etc/chrony.conf mode: 0644 overwrite: true contents: inline: | # The Machine Config Operator manages this file. server openshift-master-0.<cluster-name>.<domain> iburst 1 server openshift-master-1.<cluster-name>.<domain> iburst server openshift-master-2.<cluster-name>.<domain> iburst stratumweight 0 driftfile /var/lib/chrony/drift rtcsync makestep 10 3 bindcmdaddress 127.0.0.1 bindcmdaddress ::1 keyfile /etc/chrony.keys commandkey 1 generatecommandkey noclientlog logchange 0.5 logdir /var/log/chrony- 1

- 您必须将

<cluster-name>替换为集群名称,并将<domain>替换为完全限定域名。

使用 Butane 生成

MachineConfig对象文件99-worker-chrony-conf-override.yaml,其中包含要交付至 worker 节点的配置:$ butane 99-worker-chrony-conf-override.bu -o 99-worker-chrony-conf-override.yaml

将

99-master-chrony-conf-override.yaml策略应用到 control plane 节点。$ oc apply -f 99-master-chrony-conf-override.yaml

输出示例

machineconfig.machineconfiguration.openshift.io/99-master-chrony-conf-override created

将

99-worker-chrony-conf-override.yaml策略应用到 worker 节点。$ oc apply -f 99-worker-chrony-conf-override.yaml

输出示例

machineconfig.machineconfiguration.openshift.io/99-worker-chrony-conf-override created

检查应用的 NTP 设置的状态。

$ oc describe machineconfigpool

16.4.2. 安装后启用置备网络

通过为裸机集群提供支持的安装程序和安装程序置备安装,可以在没有 provisioning 网络的情况下部署集群。当每个节点的基板管理控制器可以通过 baremetal 网络 路由时,此功能适用于概念验证集群或仅使用 Redfish 虚拟介质单独部署的情况。

您可在安装后使用 Cluster Baremetal Operator(CBO)启用 置备 网络。

先决条件

- 必须存在专用物理网络,连接到所有 worker 和 control plane 节点。

- 您必须隔离原生、未标记的物理网络。

-

当

provisioningNetwork配置设置为Managed时,网络无法有一个 DHCP 服务器。 -

您可以省略 OpenShift Container Platform 4.10 中的

provisioningInterface设置,以使用bootMACAddress配置设置。

流程

-

设置

provisioningInterface设置时,首先确定集群节点的调配接口名称。例如:eth0oreno1。 -

在集群节点的

调配网络接口上启用预引导执行环境(PXE)。 检索

provisioning网络的当前状态,并将其保存到 provisioning 自定义资源(CR)文件中:$ oc get provisioning -o yaml > enable-provisioning-nw.yaml

修改 provisioning CR 文件:

$ vim ~/enable-provisioning-nw.yaml

向下滚动到

provisioningNetwork配置设置,并将它从Disabled改为Managed。然后,在provisioningNetwork设置后添加provisioningIP、provisioningNetworkCIDR、provisioningDHCPRange、provisioningInterface和watchAllNameSpaces配置设置。为每项设置提供适当的值。apiVersion: v1 items: - apiVersion: metal3.io/v1alpha1 kind: Provisioning metadata: name: provisioning-configuration spec: provisioningNetwork: 1 provisioningIP: 2 provisioningNetworkCIDR: 3 provisioningDHCPRange: 4 provisioningInterface: 5 watchAllNameSpaces: 6- 1

provisioningNetwork是Managed、Unmanaged 或Disabled之一。当设置为Managed时,Metal3 管理调配网络,CBO 使用配置的 DHCP 服务器部署 Metal3 pod。当设置为Unmanaged时,系统管理员手动配置 DHCP 服务器。- 2

provisioningIP是 DHCP 服务器和 ironic 用于调配网络的静态 IP 地址。这个静态 IP 地址必须在provisioning子网内,且不在 DHCP 范围内。如果配置这个设置,它必须具有有效的 IP 地址,即使provisioning网络是Disabled。静态 IP 地址绑定到 metal3 pod。如果 metal3 pod 失败并移动到其他服务器,静态 IP 地址也会移到新服务器。- 3

- 无类别域间路由(CIDR)地址。如果配置这个设置,它必须具有有效的 CIDR 地址,即使

provisioning网络是Disabled。例如:192.168.0.1/24。 - 4

- DHCP 范围。此设置仅适用于

受管置备网络。如果provisioning网络为Disabled,则省略此配置设置。例如:192.168.0.64, 192.168.0.253。 - 5

- 集群节点上

置备接口的 NIC 名称。provisioningInterface设置仅适用于受管和非受管置备网络。如果provisioning网络为Disabled,忽略provisioningInterface配置设置。省略provisioningInterface配置设置,以使用bootMACAddress配置设置。 - 6

- 如果您希望 metal3 监视默认

openshift-machine-api命名空间以外的命名空间,请将此设置设置为true。默认值为false。

- 保存对 provisioning CR 文件的更改。

将 provisioning CR 文件应用到集群:

$ oc apply -f enable-provisioning-nw.yaml

16.4.3. 外部负载均衡器的服务

您可以将 OpenShift Container Platform 集群配置为使用外部负载均衡器来代替默认负载均衡器。

配置外部负载均衡器取决于您的供应商的负载均衡器。

本节中的信息和示例仅用于指导目的。有关供应商负载均衡器的更多信息,请参阅供应商文档。

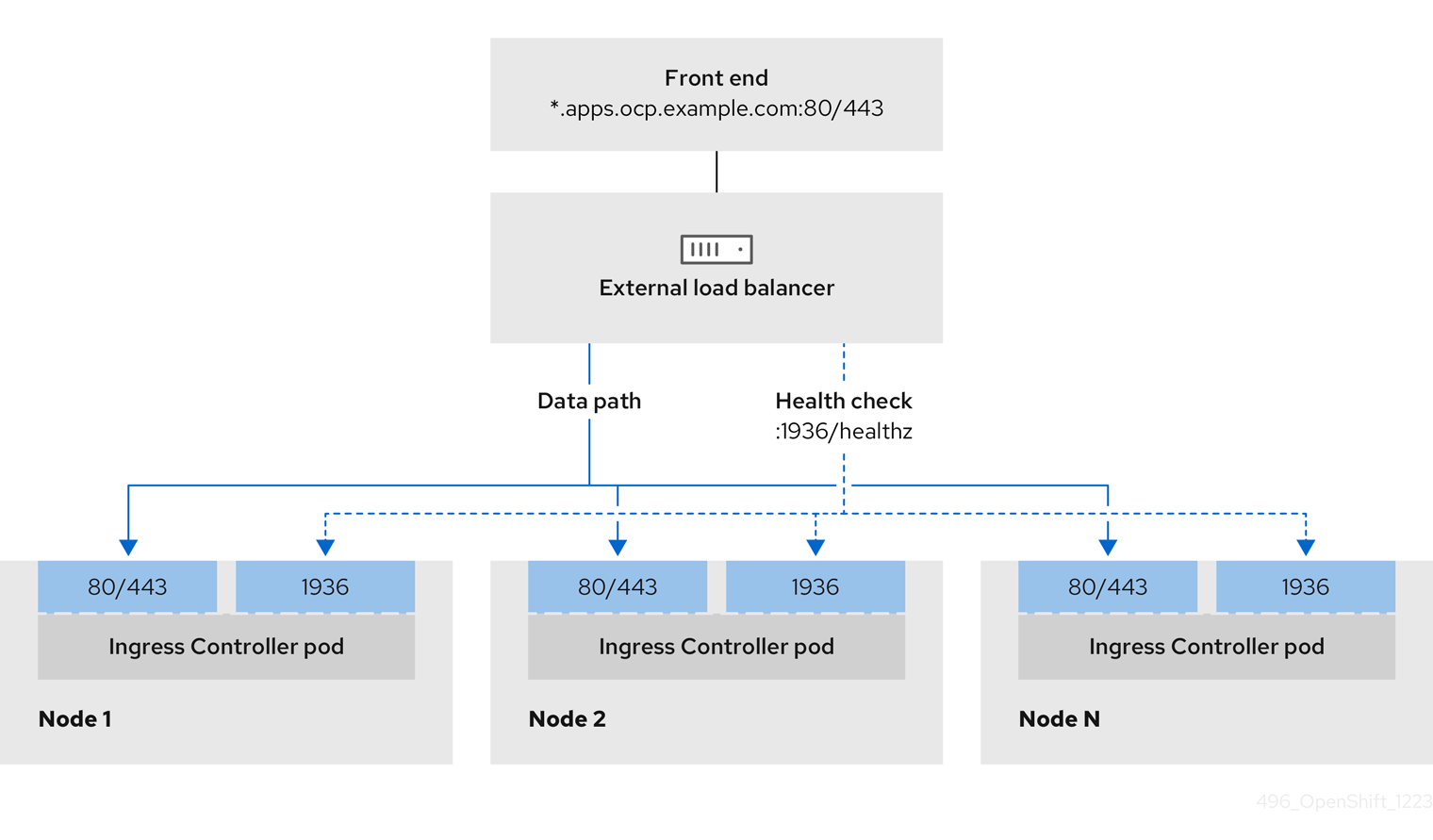

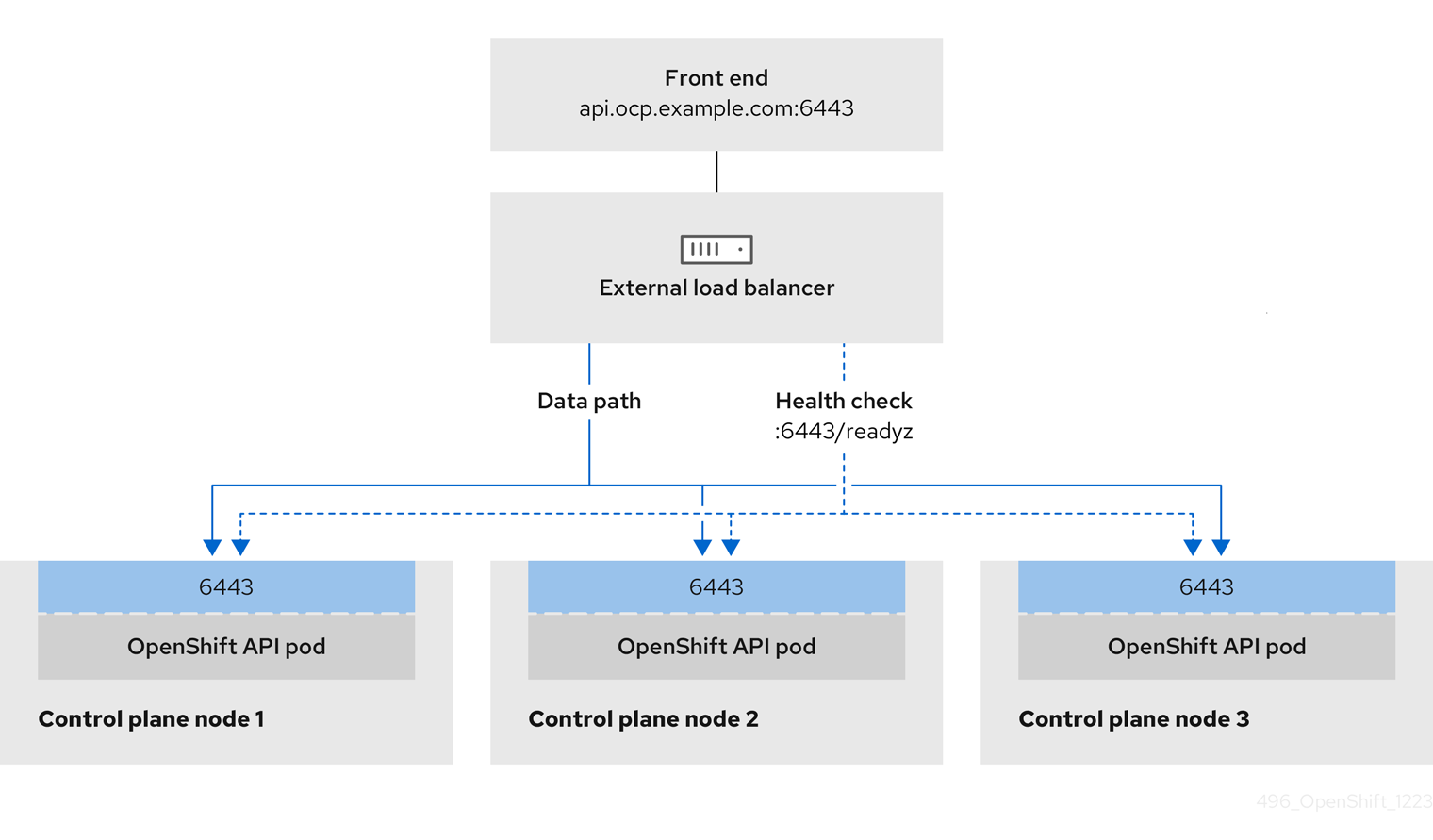

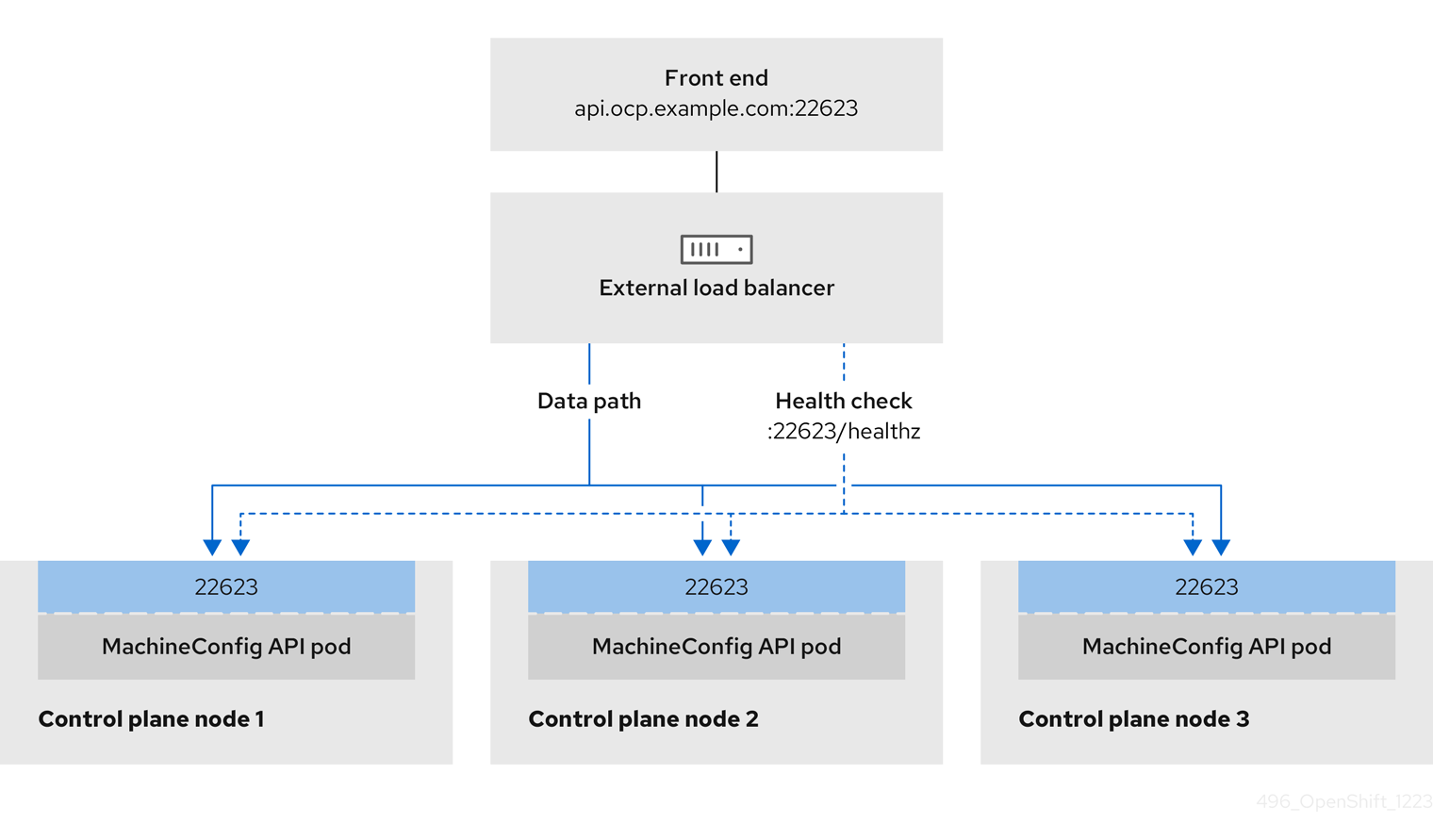

红帽支持外部负载均衡器的以下服务:

- Ingress Controller

- OpenShift API

- OpenShift MachineConfig API

您可以选择是否为外部负载均衡器配置一个或多个所有服务。仅配置 Ingress Controller 服务是一个通用的配置选项。要更好地了解每个服务,请查看以下图表:

图 16.1. 显示 OpenShift Container Platform 环境中运行的 Ingress Controller 的网络工作流示例

图 16.2. 显示 OpenShift Container Platform 环境中运行的 OpenShift API 的网络工作流示例

图 16.3. 显示 OpenShift Container Platform 环境中运行的 OpenShift MachineConfig API 的网络工作流示例

外部负载均衡器支持以下配置选项:

- 使用节点选择器将 Ingress Controller 映射到一组特定的节点。您必须为这个集合中的每个节点分配一个静态 IP 地址,或者将每个节点配置为从动态主机配置协议(DHCP)接收相同的 IP 地址。基础架构节点通常接收这种类型的配置。

以子网上的所有 IP 地址为目标。此配置可减少维护开销,因为您可以在这些网络中创建和销毁节点,而无需重新配置负载均衡器目标。如果您使用较小的网络上的机器集来部署入口 pod,如

/27或/28,您可以简化负载均衡器目标。提示您可以通过检查机器配置池的资源来列出网络中存在的所有 IP 地址。

在为 OpenShift Container Platform 集群配置外部负载均衡器前,请考虑以下信息:

- 对于前端 IP 地址,您可以对前端 IP 地址、Ingress Controller 的负载均衡器和 API 负载均衡器使用相同的 IP 地址。查看厂商的文档以获取此功能的相关信息。

对于后端 IP 地址,请确保 OpenShift Container Platform control plane 节点的 IP 地址在外部负载均衡器的生命周期内不会改变。您可以通过完成以下操作之一来实现此目的:

- 为每个 control plane 节点分配一个静态 IP 地址。

- 将每个节点配置为在每次节点请求 DHCP 租期时从 DHCP 接收相同的 IP 地址。根据供应商,DHCP 租期可能采用 IP 保留或静态 DHCP 分配的形式。

- 在 Ingress Controller 后端服务的外部负载均衡器中手动定义运行 Ingress Controller 的每个节点。例如,如果 Ingress Controller 移到未定义节点,则可能会出现连接中断。

16.4.3.1. 配置外部负载均衡器

您可以将 OpenShift Container Platform 集群配置为使用外部负载均衡器来代替默认负载均衡器。

在配置外部负载均衡器前,请确定您阅读了外部负载均衡器的"服务"部分。

阅读适用于您要为外部负载均衡器配置的服务的以下先决条件。

MetalLB,在集群中运行,充当外部负载均衡器。

OpenShift API 的先决条件

- 您定义了前端 IP 地址。

TCP 端口 6443 和 22623 在负载均衡器的前端 IP 地址上公开。检查以下项:

- 端口 6443 提供对 OpenShift API 服务的访问。

- 端口 22623 可以为节点提供 ignition 启动配置。

- 前端 IP 地址和端口 6443 可以被您的系统的所有用户访问,其位置为 OpenShift Container Platform 集群外部。

- 前端 IP 地址和端口 22623 只能被 OpenShift Container Platform 节点访问。

- 负载均衡器后端可以在端口 6443 和 22623 上与 OpenShift Container Platform control plane 节点通信。

Ingress Controller 的先决条件

- 您定义了前端 IP 地址。

- TCP 端口 443 和 80 在负载均衡器的前端 IP 地址上公开。

- 前端 IP 地址、端口 80 和端口 443 可以被您的系统所有用户访问,以及 OpenShift Container Platform 集群外部的位置。

- 前端 IP 地址、端口 80 和端口 443 可被 OpenShift Container Platform 集群中运行的所有节点访问。

- 负载均衡器后端可以在端口 80、443 和 1936 上与运行 Ingress Controller 的 OpenShift Container Platform 节点通信。

健康检查 URL 规格的先决条件

您可以通过设置健康检查 URL 来配置大多数负载均衡器,以确定服务是否可用或不可用。OpenShift Container Platform 为 OpenShift API、Machine Configuration API 和 Ingress Controller 后端服务提供这些健康检查。

以下示例演示了以前列出的后端服务的健康检查规格:

Kubernetes API 健康检查规格示例

Path: HTTPS:6443/readyz Healthy threshold: 2 Unhealthy threshold: 2 Timeout: 10 Interval: 10

Machine Config API 健康检查规格示例

Path: HTTPS:22623/healthz Healthy threshold: 2 Unhealthy threshold: 2 Timeout: 10 Interval: 10

Ingress Controller 健康检查规格示例

Path: HTTP:1936/healthz/ready Healthy threshold: 2 Unhealthy threshold: 2 Timeout: 5 Interval: 10

流程

配置 HAProxy Ingress Controller,以便您可以在端口 6443、443 和 80 上从负载均衡器访问集群:

HAProxy 配置示例

#... listen my-cluster-api-6443 bind 192.168.1.100:6443 mode tcp balance roundrobin option httpchk http-check connect http-check send meth GET uri /readyz http-check expect status 200 server my-cluster-master-2 192.168.1.101:6443 check inter 10s rise 2 fall 2 server my-cluster-master-0 192.168.1.102:6443 check inter 10s rise 2 fall 2 server my-cluster-master-1 192.168.1.103:6443 check inter 10s rise 2 fall 2 listen my-cluster-machine-config-api-22623 bind 192.168.1.100:22623 mode tcp balance roundrobin option httpchk http-check connect http-check send meth GET uri /healthz http-check expect status 200 server my-cluster-master-2 192.168.1.101:22623 check inter 10s rise 2 fall 2 server my-cluster-master-0 192.168.1.102:22623 check inter 10s rise 2 fall 2 server my-cluster-master-1 192.168.1.103:22623 check inter 10s rise 2 fall 2 listen my-cluster-apps-443 bind 192.168.1.100:443 mode tcp balance roundrobin option httpchk http-check connect http-check send meth GET uri /healthz/ready http-check expect status 200 server my-cluster-worker-0 192.168.1.111:443 check port 1936 inter 10s rise 2 fall 2 server my-cluster-worker-1 192.168.1.112:443 check port 1936 inter 10s rise 2 fall 2 server my-cluster-worker-2 192.168.1.113:443 check port 1936 inter 10s rise 2 fall 2 listen my-cluster-apps-80 bind 192.168.1.100:80 mode tcp balance roundrobin option httpchk http-check connect http-check send meth GET uri /healthz/ready http-check expect status 200 server my-cluster-worker-0 192.168.1.111:80 check port 1936 inter 10s rise 2 fall 2 server my-cluster-worker-1 192.168.1.112:80 check port 1936 inter 10s rise 2 fall 2 server my-cluster-worker-2 192.168.1.113:80 check port 1936 inter 10s rise 2 fall 2 # ...使用

curlCLI 命令验证外部负载均衡器及其资源是否正常运行:运行以下命令并查看响应,验证集群机器配置 API 是否可以被 Kubernetes API 服务器资源访问:

$ curl https://<loadbalancer_ip_address>:6443/version --insecure

如果配置正确,您会收到 JSON 对象的响应:

{ "major": "1", "minor": "11+", "gitVersion": "v1.11.0+ad103ed", "gitCommit": "ad103ed", "gitTreeState": "clean", "buildDate": "2019-01-09T06:44:10Z", "goVersion": "go1.10.3", "compiler": "gc", "platform": "linux/amd64" }运行以下命令并观察输出,验证集群机器配置 API 是否可以被 Machine 配置服务器资源访问:

$ curl -v https://<loadbalancer_ip_address>:22623/healthz --insecure

如果配置正确,命令的输出会显示以下响应:

HTTP/1.1 200 OK Content-Length: 0

运行以下命令并观察输出,验证控制器是否可以被端口 80 上的 Ingress Controller 资源访问:

$ curl -I -L -H "Host: console-openshift-console.apps.<cluster_name>.<base_domain>" http://<load_balancer_front_end_IP_address>

如果配置正确,命令的输出会显示以下响应:

HTTP/1.1 302 Found content-length: 0 location: https://console-openshift-console.apps.ocp4.private.opequon.net/ cache-control: no-cache

运行以下命令并观察输出,验证控制器是否可以被端口 443 上的 Ingress Controller 资源访问:

$ curl -I -L --insecure --resolve console-openshift-console.apps.<cluster_name>.<base_domain>:443:<Load Balancer Front End IP Address> https://console-openshift-console.apps.<cluster_name>.<base_domain>

如果配置正确,命令的输出会显示以下响应:

HTTP/1.1 200 OK referrer-policy: strict-origin-when-cross-origin set-cookie: csrf-token=UlYWOyQ62LWjw2h003xtYSKlh1a0Py2hhctw0WmV2YEdhJjFyQwWcGBsja261dGLgaYO0nxzVErhiXt6QepA7g==; Path=/; Secure; SameSite=Lax x-content-type-options: nosniff x-dns-prefetch-control: off x-frame-options: DENY x-xss-protection: 1; mode=block date: Wed, 04 Oct 2023 16:29:38 GMT content-type: text/html; charset=utf-8 set-cookie: 1e2670d92730b515ce3a1bb65da45062=1bf5e9573c9a2760c964ed1659cc1673; path=/; HttpOnly; Secure; SameSite=None cache-control: private

为您的集群配置 DNS 记录,以外部负载均衡器的前端 IP 地址为目标。您必须在负载均衡器上将记录更新为集群 API 和应用程序的 DNS 服务器。

修改 DNS 记录示例

<load_balancer_ip_address> A api.<cluster_name>.<base_domain> A record pointing to Load Balancer Front End

<load_balancer_ip_address> A apps.<cluster_name>.<base_domain> A record pointing to Load Balancer Front End

重要DNS 传播可能需要一些时间才能获得每个 DNS 记录。在验证每个记录前,请确保每个 DNS 记录传播。

使用

curlCLI 命令验证外部负载均衡器和 DNS 记录配置是否正常运行:运行以下命令并查看输出,验证您可以访问集群 API:

$ curl https://api.<cluster_name>.<base_domain>:6443/version --insecure

如果配置正确,您会收到 JSON 对象的响应:

{ "major": "1", "minor": "11+", "gitVersion": "v1.11.0+ad103ed", "gitCommit": "ad103ed", "gitTreeState": "clean", "buildDate": "2019-01-09T06:44:10Z", "goVersion": "go1.10.3", "compiler": "gc", "platform": "linux/amd64" }运行以下命令并查看输出,验证您可以访问集群机器配置:

$ curl -v https://api.<cluster_name>.<base_domain>:22623/healthz --insecure

如果配置正确,命令的输出会显示以下响应:

HTTP/1.1 200 OK Content-Length: 0

运行以下命令并查看输出,验证您可以在端口上访问每个集群应用程序:

$ curl http://console-openshift-console.apps.<cluster_name>.<base_domain -I -L --insecure

如果配置正确,命令的输出会显示以下响应:

HTTP/1.1 302 Found content-length: 0 location: https://console-openshift-console.apps.<cluster-name>.<base domain>/ cache-control: no-cacheHTTP/1.1 200 OK referrer-policy: strict-origin-when-cross-origin set-cookie: csrf-token=39HoZgztDnzjJkq/JuLJMeoKNXlfiVv2YgZc09c3TBOBU4NI6kDXaJH1LdicNhN1UsQWzon4Dor9GWGfopaTEQ==; Path=/; Secure x-content-type-options: nosniff x-dns-prefetch-control: off x-frame-options: DENY x-xss-protection: 1; mode=block date: Tue, 17 Nov 2020 08:42:10 GMT content-type: text/html; charset=utf-8 set-cookie: 1e2670d92730b515ce3a1bb65da45062=9b714eb87e93cf34853e87a92d6894be; path=/; HttpOnly; Secure; SameSite=None cache-control: private

运行以下命令并查看输出,验证您可以在端口 443 上访问每个集群应用程序:

$ curl https://console-openshift-console.apps.<cluster_name>.<base_domain> -I -L --insecure

如果配置正确,命令的输出会显示以下响应:

HTTP/1.1 200 OK referrer-policy: strict-origin-when-cross-origin set-cookie: csrf-token=UlYWOyQ62LWjw2h003xtYSKlh1a0Py2hhctw0WmV2YEdhJjFyQwWcGBsja261dGLgaYO0nxzVErhiXt6QepA7g==; Path=/; Secure; SameSite=Lax x-content-type-options: nosniff x-dns-prefetch-control: off x-frame-options: DENY x-xss-protection: 1; mode=block date: Wed, 04 Oct 2023 16:29:38 GMT content-type: text/html; charset=utf-8 set-cookie: 1e2670d92730b515ce3a1bb65da45062=1bf5e9573c9a2760c964ed1659cc1673; path=/; HttpOnly; Secure; SameSite=None cache-control: private