安装

安装并配置 OpenShift Container Platform 集群

摘要

第 1 章 OpenShift Container Platform 安装概述

1.1. OpenShift Container Platform 安装概述

OpenShift Container Platform 安装程序为您提供了灵活性。您可以使用安装程序将集群部署到由安装程序置备并由集群维护的基础架构中,也可以将集群部署到您自己准备和维护的基础架构中。

这两种基本类型的 OpenShift Container Platform 集群通常称为安装程序置备的基础架构集群和用户置备的基础架构集群。

两种类型的集群都具有以下特征:

- 默认提供无单点故障的高可用性基础架构

- 管理员可以控制要应用的更新内容和更新的时间

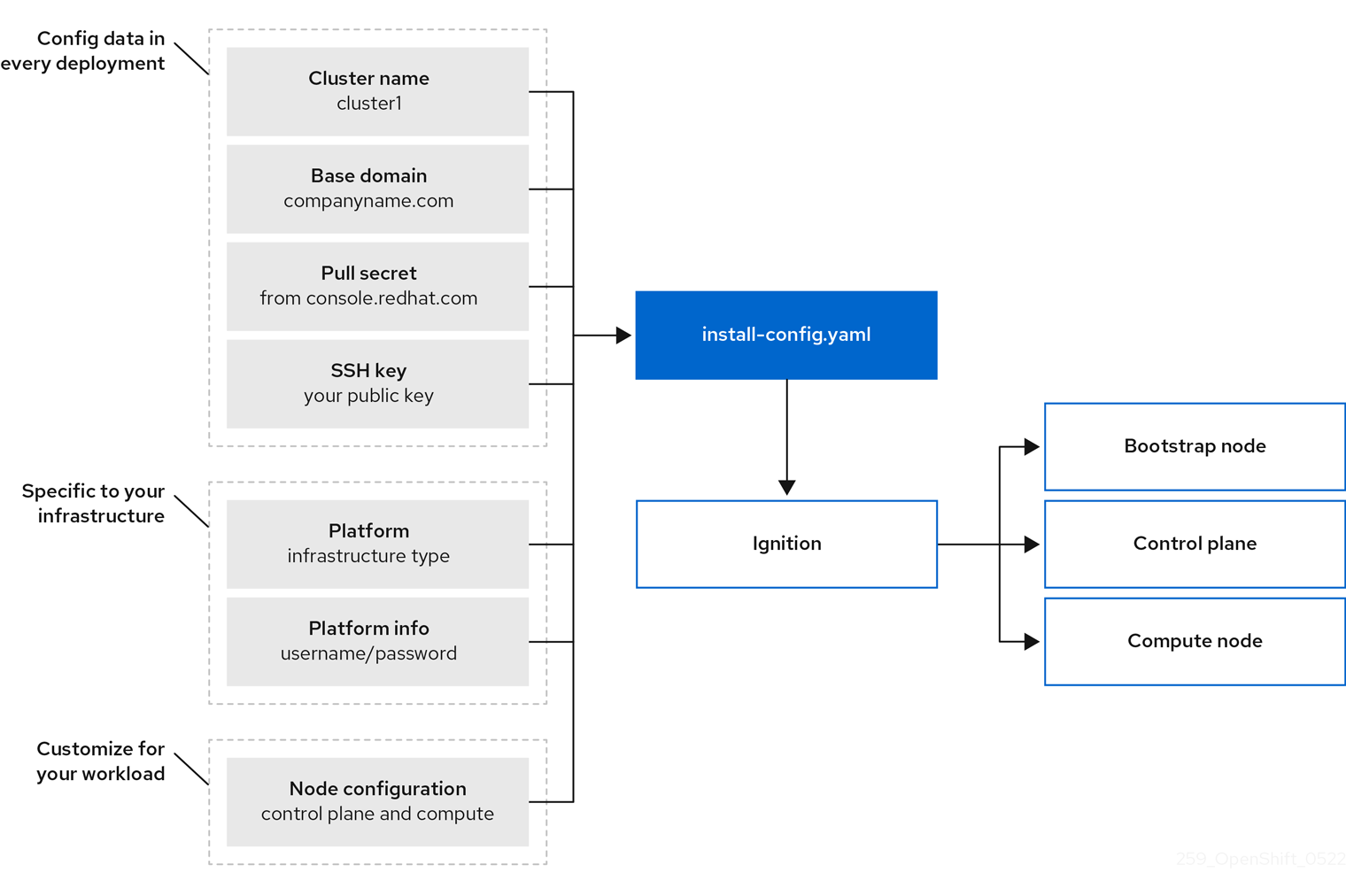

两种类型的集群都使用同一个安装程序来部署。安装程序生成的主要资产是用于 Bootstrap、master 和 worker 机器的 Ignition 配置文件。有了这三个配置和配置得当的基础架构,就能启动 OpenShift Container Platform 集群。

OpenShift Container Platform 安装程序使用一组目标和依赖项来管理集群安装。安装程序具有一组必须实现的目标,并且每个目标都有一组依赖项。因为每个目标仅关注其自己的依赖项,所以安装程序可以采取措施来并行实现多个目标。最终目标是正常运行的集群。通过满足依赖项而不是运行命令,安装程序能够识别和使用现有的组件,而不必运行命令来再次创建它们。

下图显示了安装目标和依赖项的子集:

图 1.1. OpenShift Container Platform 安装目标和依赖项

在安装后,每一个集群机器都将使用 Red Hat Enterprise Linux CoreOS (RHCOS) 作为操作系统。RHCOS 是 Red Hat Enterprise Linux (RHEL) 的不可变容器主机版本,具有默认启用 SELinux 的 RHEL 内核。它包括作为 Kubernetes 节点代理的 kubelet,以及为 Kubernetes 优化的 CRI-O 容器运行时。

OpenShift Container Platform 4.10 集群中的每一 control plane 机器都必须使用 RHCOS,其中包括一个关键的首次启动置备工具,称为 Ignition。这一工具让集群能够配置机器。操作系统更新作为嵌入在容器镜像中的 Atomic OSTree 存储库交付,该镜像由 Operator 在整个集群中推广。实际的操作系统更改通过使用 rpm-ostree 在每台机器上作为原子操作原位进行。通过结合使用这些技术,OpenShift Container Platform 可以像管理集群上的任何其他应用程序一样管理操作系统,通过原位升级使整个平台保持最新状态。这些原位更新可以减轻运维团队的负担。

如果将 RHCOS 用作所有集群机器的操作系统,则集群将管理其组件和机器的所有方面,包括操作系统在内。因此,只有安装程序和 Machine Config Operator 才能更改机器。安装程序使用 Ignition 配置文件设置每台机器的确切状态,安装后则由 Machine Config Operator 完成对机器的更多更改,例如应用新证书或密钥等。

1.1.1. 安装过程

安装 OpenShift Container Platform 集群时,您可以从 OpenShift Cluster Manager 站点的适当 Infrastructure Provider 页面下载安装程序。此网站管理以下内容:

- 帐户的 REST API

- registry 令牌,这是用于获取所需组件的 pull secret

- 集群注册,它将集群身份信息与您的红帽帐户相关联,以方便收集使用情况指标

在 OpenShift Container Platform 4.10 中,安装程序是对一组资产执行一系列文件转换的 Go 二进制文件。与安装程序交互的方式因您的安装类型而异。

- 对于具有安装程序置备的基础架构集群,您可以将基础架构启动和置备委派给安装程序,而不是亲自执行。安装程序将创建支持集群所需的所有网络、机器和操作系统。

- 如果亲自为集群置备和管理基础架构,则必须提供所有集群基础架构和资源,包括 Bootstrap 机器、网络、负载均衡、存储和独立的集群机器。

安装期间使用三组文件:名为 install-config.yaml 的安装配置文件、Kubernetes 清单,以及您的机器类型适用的 Ignition 配置文件。

安装期间可以修改控制基础 RHCOS 操作系统的 Kubernetes 和 Ignition 配置文件。但是,没有可用的验证机制来确认您对这些对象所做修改是适当的。如果修改了这些对象,集群可能会无法运行。由于存在这种风险,修改 Kubernetes 和 Ignition 配置文件不受支持,除非您遵循记录的流程或在红帽支持指示下操作。

安装配置文件转换为 Kubernetes 清单,然后清单嵌套到 Ignition 配置文件中。安装程序使用这些 Ignition 配置文件来创建集群。

运行安装程序时,所有配置文件会被修剪,因此请务必备份需要再次使用的所有配置文件。

安装之后,您无法修改在安装过程中设置的参数,但可以修改一些集群属性。

采用安装程序置备的基础架构的安装过程

默认安装类型为使用安装程序置备的基础架构。默认情况下,安装程序充当安装向导,提示您输入它无法自行确定的值,并为其余参数提供合理的默认值。您还可以自定义安装过程来支持高级基础架构场景。安装程序将为集群置备底层基础架构。

您可以安装标准集群或自定义集群。对于标准集群,您要提供安装集群所需的最低限度详细信息。对于自定义集群,您可以指定有关平台的更多详细信息,如 control plane 使用的机器数量、集群部署的虚拟机的类型,或 Kubernetes 服务网络的 CIDR 范围。

若有可能,可以使用此功能来避免置备和维护集群基础架构。在所有其他环境中,可以使用安装程序来生成置备集群基础架构所需的资产。

对于安装程序置备的基础架构的集群,OpenShift Container Platform 可以管理集群的所有方面,包括操作系统本身。每台机器在启动时使用的配置引用其加入的集群中托管的资源。此配置允许集群在应用更新时自行管理。

采用用户置备的基础架构的安装过程

您还可以在自己提供的基础架构上安装 OpenShift Container Platform。您可以使用安装程序来生成置备集群基础架构所需的资产,再创建集群基础架构,然后将集群部署到您提供的基础架构中。

如果不使用安装程序置备的基础架构,您必须自己管理和维护集群资源,包括:

- 组成集群的 control plane 和计算机器的底层基础架构

- 负载均衡器

- 集群网络,包括 DNS 记录和所需的子网

- 集群基础架构和应用程序的存储

如果您的集群使用用户置备的基础架构,您可以选择将 RHEL 计算机器添加到集群中。

安装过程详细信息

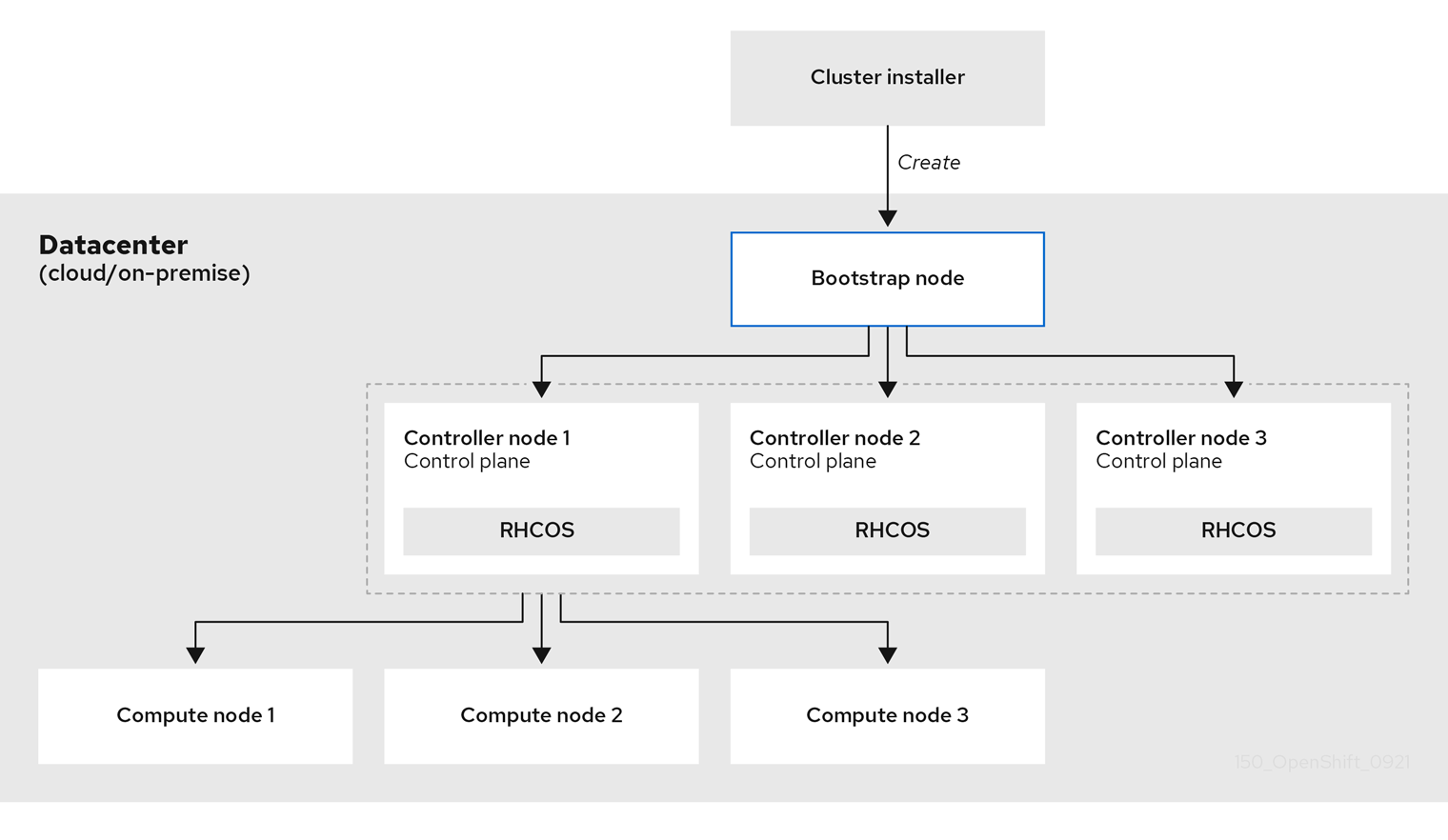

由于在置备时集群中的每台机器都需要集群的相关信息,因此 OpenShift Container Platform 在初始配置期间会使用临时 Bootstrap 机器将所需的信息提供给持久 control plane。通过使用描述如何创建集群的 Ignition 配置文件进行启动。bootstrap 机器创建组成 control plane 的 control plane 机器。然后,control plane 机器创建计算(compute)机器。下图说明了这一过程:

图 1.2. 创建 bootstrap、control plane 和计算机器

集群机器初始化后,Bootstrap 机器将被销毁。所有集群都使用 Bootstrap 过程来初始化集群,但若您自己置备集群的基础架构,则必须手动完成许多步骤。

-

安装程序生成的 Ignition 配置文件包含在 24 小时后过期的证书,然后在过期时进行续订。如果在更新证书前关闭集群,且集群在 24 小时后重启,集群会自动恢复过期的证书。一个例外是,您必须手动批准待处理的

node-bootstrapper证书签名请求(CSR)来恢复 kubelet 证书。如需更多信息,请参阅从过期的 control plane 证书 中恢复的文档。 - 建议您在 Ignition 配置文件生成后的 12 小时内使用它们,因为 24 小时的证书会在集群安装后的 16 小时到 22 小时间进行轮转。通过在 12 小时内使用 Ignition 配置文件,您可以避免在安装过程中因为执行了证书更新而导致安装失败的问题。

bootstrapp 集群涉及以下步骤:

- bootstrap 机器启动并开始托管 control plane 机器引导所需的远程资源。(如果自己配置基础架构,则需要人工干预)

- bootstrap 机器启动单节点 etcd 集群和一个临时 Kubernetes control plane。

- control plane 机器从 bootstrap 机器获取远程资源并完成启动。(如果自己配置基础架构,则需要人工干预)

- 临时 control plane 将生产环境的 control plane 调度到生产环境 control plane 机器。

- Cluster Version Operator(CVO)在线并安装 etcd Operator。etcd Operator 在所有 control plane 节点上扩展 etcd。

- 临时 control plane 关机,并将控制权交给生产环境 control plane。

- bootstrap 机器将 OpenShift Container Platform 组件注入生产环境 control plane。

- 安装程序关闭 bootstrap 机器。(如果自己配置基础架构,则需要人工干预)

- control plane 设置计算节点。

- control plane 以一组 Operator 的形式安装其他服务。

完成此 bootstrap 过程后,将生成一个全面运作的 OpenShift Container Platform 集群。然后,集群下载并配置日常运作所需的其余组件,包括在受支持的环境中创建计算(compute)机器。

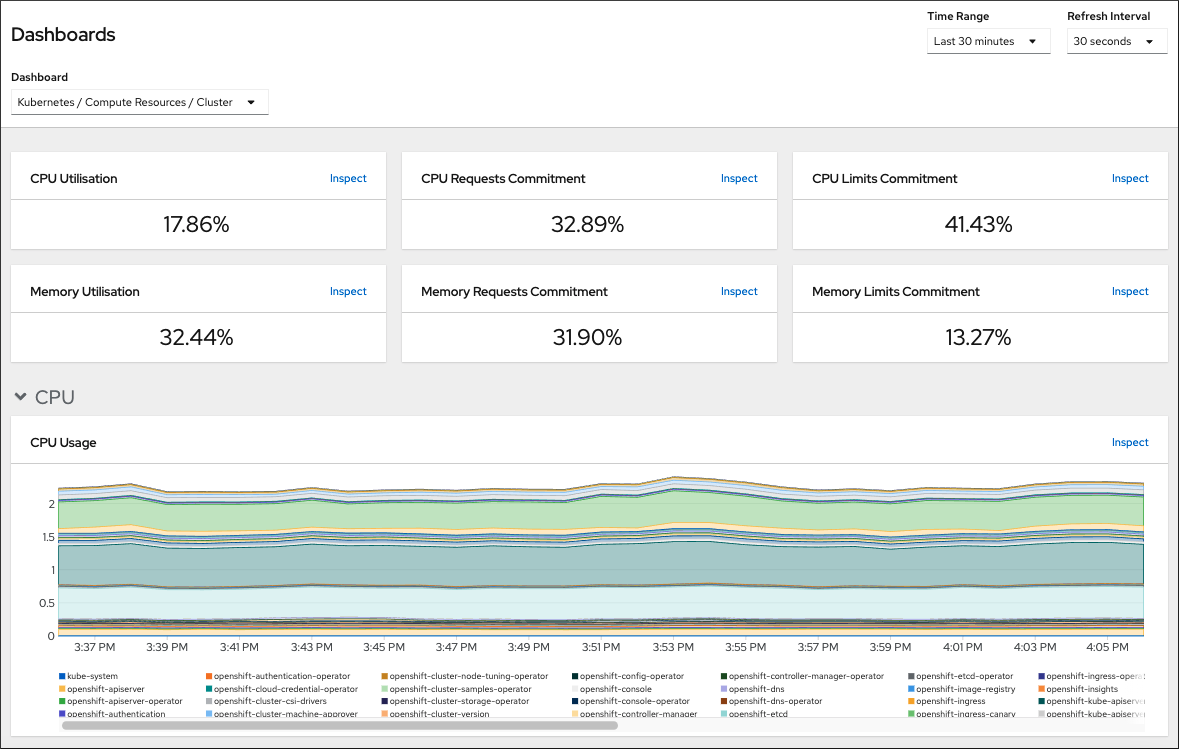

1.1.2. 安装后验证节点状态

当以下安装健康检查成功时,OpenShift Container Platform 安装会完成:

- 置备程序可以访问 OpenShift Container Platform Web 控制台。

- 所有 control plane 节点都已就绪。

- 所有集群 Operator 都可用。

安装完成后,负责 worker 节点的特定集群 Operator 持续尝试置备所有 worker 节点。可能需要稍等片刻,所有 worker 节点都会报告为 READY。对于在裸机上的安装,请等待至少 60 分钟,然后对 worker 节点进行故障排除。对于所有其他平台上安装,请等待至少 40 分钟后再对 worker 节点进行故障排除。负责 worker 节点的集群 Operator 的 DEGRADED 状态取决于 Operator 自己的资源,而不是节点的状态。

安装完成后,您可以使用以下步骤继续监控集群中的节点条件。

先决条件

- 安装程序在终端中成功解决。

流程

显示所有 worker 节点的状态:

$ oc get nodes

输出示例

NAME STATUS ROLES AGE VERSION example-compute1.example.com Ready worker 13m v1.21.6+bb8d50a example-compute2.example.com Ready worker 13m v1.21.6+bb8d50a example-compute4.example.com Ready worker 14m v1.21.6+bb8d50a example-control1.example.com Ready master 52m v1.21.6+bb8d50a example-control2.example.com Ready master 55m v1.21.6+bb8d50a example-control3.example.com Ready master 55m v1.21.6+bb8d50a

显示所有 worker 机器节点的阶段:

$ oc get machines -A

输出示例

NAMESPACE NAME PHASE TYPE REGION ZONE AGE openshift-machine-api example-zbbt6-master-0 Running 95m openshift-machine-api example-zbbt6-master-1 Running 95m openshift-machine-api example-zbbt6-master-2 Running 95m openshift-machine-api example-zbbt6-worker-0-25bhp Running 49m openshift-machine-api example-zbbt6-worker-0-8b4c2 Running 49m openshift-machine-api example-zbbt6-worker-0-jkbqt Running 49m openshift-machine-api example-zbbt6-worker-0-qrl5b Running 49m

其他资源

安装范围

OpenShift Container Platform 安装程序的作用范围特意设计得比较狭窄。它旨在简化操作并确保成功。安装完成后,您可以完成更多的配置任务。

其他资源

- 如需有关 OpenShift Container Platform 配置资源的详细信息,请参阅可用的集群自定义。

1.1.3. OpenShift Local 概述

OpenShift Local 支持快速应用程序开发,以开始构建 OpenShift Container Platform 集群。OpenShift Local 设计为在本地计算机上运行,以简化设置和测试,并使用开发基于容器的应用所需的所有工具在本地模拟云环境。

无论您使用什么编程语言,OpenShift Local 都可以托管您的应用程序,并将最小预配置的 Red Hat OpenShift Container Platform 集群引入本地 PC,而无需基于服务器的基础架构。

在托管环境中,OpenShift Local 可以创建微服务,将它们转换为镜像,并在运行 Linux、macOS 或 Windows 10 或更高版本的笔记本电脑或桌面上直接运行它们。

如需有关 OpenShift Local 的更多信息,请参阅 Red Hat OpenShift Local Overview。

1.2. OpenShift Container Platform 集群支持的平台

在 OpenShift Container Platform 4.10 中,您可以在以下平台上安装使用安装程序置备的基础架构集群:

- Amazon Web Services (AWS)

- Google Cloud Platform (GCP)

- Microsoft Azure

- Microsoft Azure Stack Hub

Red Hat OpenStack Platform (RHOSP) 版本 16.1 和 16.2

- 最新的 OpenShift Container Platform 版本支持最新的 RHOSP 长生命版本和中间版本。如需完整的 RHOSP 发行版本兼容性信息,请参阅 RHOSP 上的 OpenShift Container Platform 支持列表。

- IBM Cloud VPC

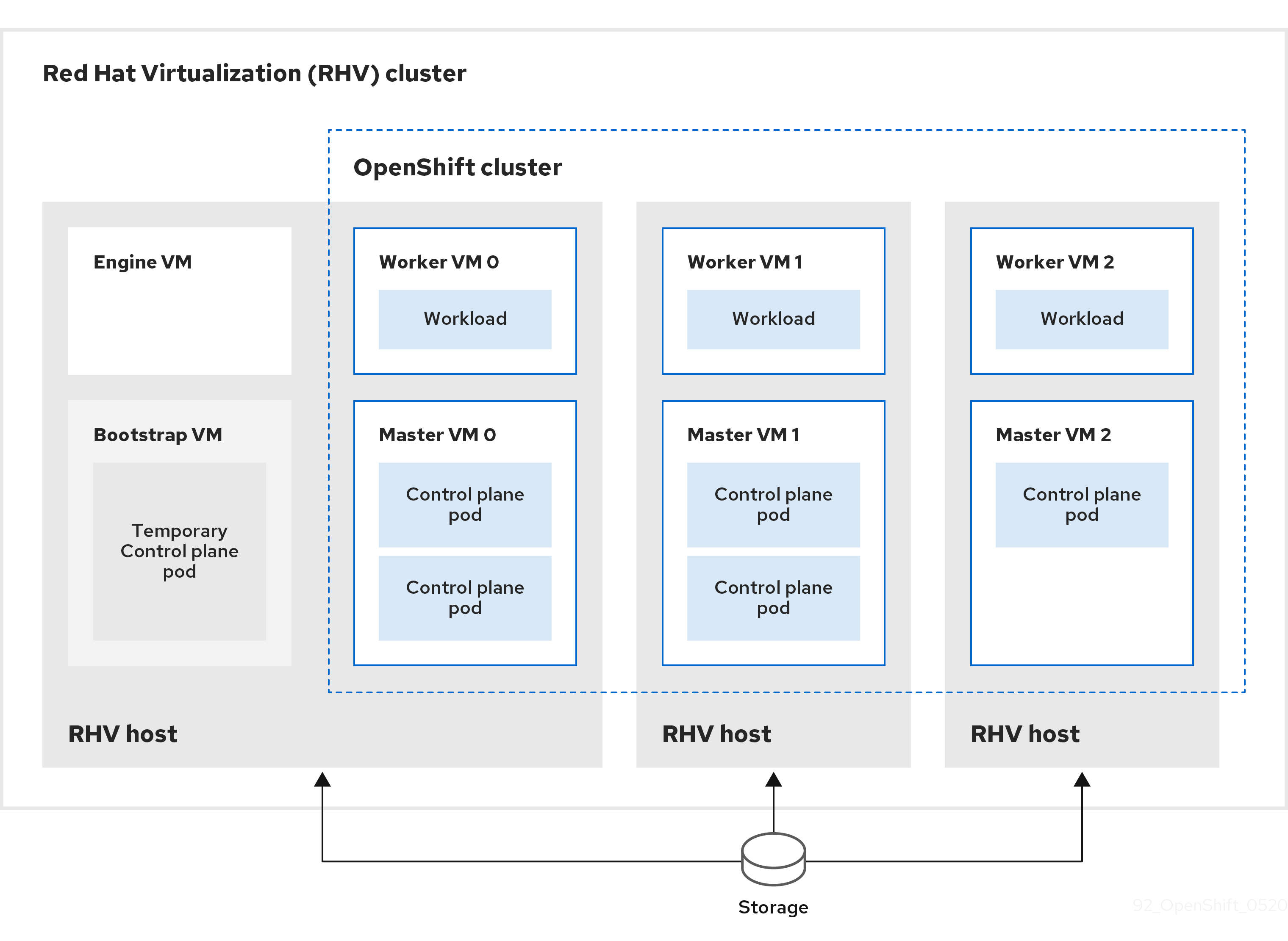

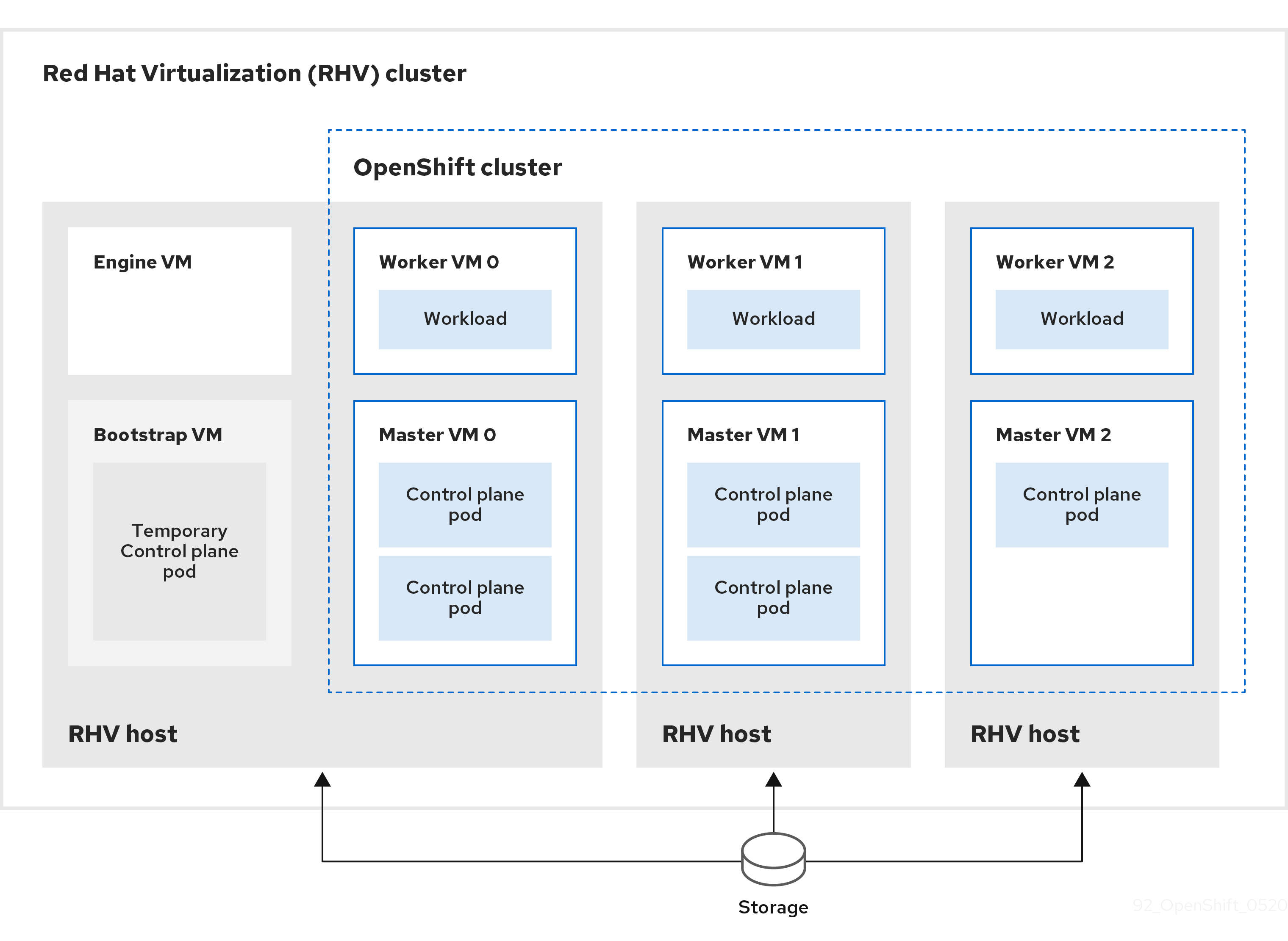

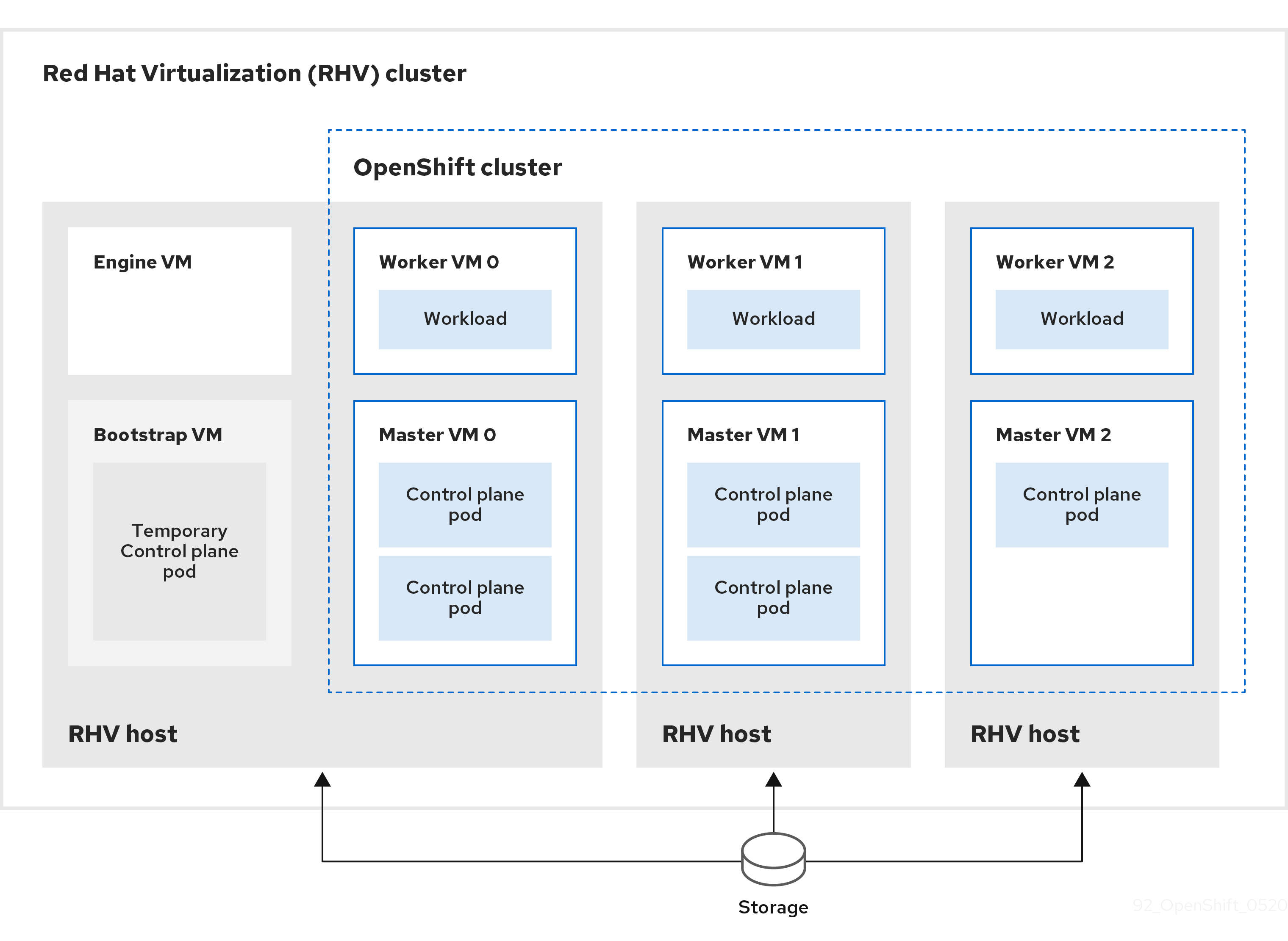

- Red Hat Virtualization(RHV)

- VMware vSphere

- AWS 上的 VMware Cloud(VMC)

- Alibaba Cloud

- 裸机

对于所有这些集群,包括用来运行安装过程的计算机在内的所有机器都必须可直接访问互联网,以便为平台容器拉取镜像并向红帽提供 telemetry 数据。

安装后,不支持以下更改:

- 混合云供应商平台

- 混合云供应商组件,比如使用与安装集群不同的平台中的持久性存储框架

在 OpenShift Container Platform 4.10 中,您可以在以下平台上安装使用用户置备的基础架构集群:

- AWS

- Azure

- Azure Stack Hub

- GCP

- RHOSP 版本 16.1 和 16.2

- RHV

- VMware vSphere

- AWS 上的 VMware Cloud

- 裸机

- IBM Z 或 LinuxONE

- IBM Power

根据平台支持的用例,在用户置备的基础架构上安装,您可以使用完全互联网访问来运行机器,将集群放置在代理后面,或者执行受限网络安装。在受限网络安装中,您可以下载安装集群所需的镜像(image),将它们放在镜像 registry(mirror registry)中,然后使用那些数据安装集群。虽然您需要访问互联网来为平台容器拉取镜像,但在 vSphere 或裸机基础架构上进行受限网络安装,您的集群机器不需要直接访问互联网。

OpenShift Container Platform 4.x Tested Integrations 页面中提供了有关针对不同平台进行集成测试的详细信息。

其他资源

- 如需了解每个支持的平台可用的安装类型的更多信息,请参阅不同平台支持的安装方法。

- 有关选择安装方法以及准备所需资源的信息,请参阅选择集群安装方法并为用户准备。

第 2 章 选择集群安装方法并为用户准备它

在安装 OpenShift Container Platform 前,请确定您具备为用户准备集群所需的所有所需资源。

2.1. 选择集群安装类型

在安装 OpenShift Container Platform 集群前,需要选择最佳安装说明。请考虑您对以下问题的回答,以选择最佳选择。

2.1.1. 您要自己安装和管理 OpenShift Container Platform 集群吗?

如果要自己安装和管理 OpenShift Container Platform,您可以在以下平台上安装它:

- Alibaba Cloud

- 64 位 x86 实例上的 Amazon Web Services (AWS)

- 64 位 ARM 实例上的 Amazon Web Services (AWS)

- Microsoft Azure

- Microsoft Azure Stack Hub

- Google Cloud Platform (GCP)

- Red Hat OpenStack Platform (RHOSP)

- Red Hat Virtualization (RHV)

- IBM Cloud VPC

- IBM Z 和 LinuxONE

- 用于 Red Hat Enterprise Linux(RHEL)KVM 的 IBM Z 和 LinuxONE

- IBM Power

- VMware vSphere

- AWS 上的 VMware Cloud(VMC)

- 裸机或其他平台基础架构

您可以将 OpenShift Container Platform 4 集群部署到内部硬件环境,或部署到云托管服务中,但集群中的所有机器都必须位于相同的数据中心或云托管服务中。

如果要使用 OpenShift Container Platform,但不想自行管理集群,则有几个受管服务选项。如果要完全由红帽管理的集群,可以使用 OpenShift Dedicated 或 OpenShift Online。您还可以在 Azure、AWS、IBM Cloud VPC 或 Google Cloud 上使用 OpenShift 作为受管服务。有关受管服务的更多信息,请参阅 OpenShift 产品页。如果您安装了使用云虚拟机作为虚拟裸机的 OpenShift Container Platform 集群,则其对应的基于云的存储不被支持。

2.1.2. 您是否已使用了 OpenShift Container Platform 3 且要使用 OpenShift Container Platform 4?

如果您已使用了 OpenShift Container Platform 3 并希望尝试 OpenShift Container Platform 4,则需要了解 OpenShift Container Platform 4 的不同。OpenShift Container Platform 4 将无缝地集成了软件包、部署和管理 Kubernetes 应用程序以及平台在 Red Hat Enterprise Linux CoreOS(RHCOS)上运行的 Operator。与其他需要部署机器并配置其操作系统以便在其中安装 OpenShift Container Platform 的系统不同,RHCOS 操作系统是 OpenShift Container Platform 集群的一个内部组成部分。在 OpenShift Container Platform 的安装过程中为集群机器部署操作系统。请参阅 OpenShift Container Platform 3 和 4 之间的差别。

由于需要置备机器作为 OpenShift Container Platform 集群安装过程的一部分,所以无法将 OpenShift Container Platform 3 集群升级到 OpenShift Container Platform 4。相反,您必须创建新的 OpenShift Container Platform 4 集群,并将 OpenShift Container Platform 3 工作负载迁移到它们。有关迁移的更多信息,请参阅从 OpenShift Container Platform 3 迁移到 4 概述。由于必须迁移到 OpenShift Container Platform 4,因此可以使用任何类型的生产环境集群安装过程来创建新集群。

2.1.3. 您是否希望在您的集群中使用已存在的组件?

由于操作系统是 OpenShift Container Platform 集成的一部分,因此让安装程序可以更轻松地支持所有基础架构。它们被称为安装程序置备的基础架构 安装。在这种安装中,您可以为集群提供一些现有的基础架构,但安装程序会部署集群初始需要的所有机器。

您可以在不对集群或其底层机器自定义 Alibaba Cloud, AWS, Azure, Azure Stack Hub, GCP, 或 VMC on AWS 的情况下部署安装程序置备的基础架构集群。这些安装方法是部署具有生产环境性 OpenShift Container Platform 集群的最快方法。

如果需要为安装程序置备的基础架构集群执行基本配置,如集群机器的实例类型,您可以自定义 Alibaba Cloud, AWS, Azure, GCP, 或 VMC on AWS 的安装。

对于安装程序置备的基础架构安装,您可以使用现存的 VPC in AWS, vNet in Azure, 或 VPC in GCP。您还可以重复使用网络基础架构的一部分,以便 AWS、Azure、GCP 或 VMC on AWS 可以与环境中现有的 IP 地址分配共存,并与现有的 MTU 和 VXLAN 配置集成。如果在这些云上已有帐户和凭证,您可以重复使用这些帐户,但可能需要修改帐户,以便具有在它们上安装 OpenShift Container Platform 集群所需的权限。

您可以使用安装程序置备的基础架构方法为 RHOSP、带有 Kuryr 的 RHOSP、SR-IOV 上的 RHOSP、RHV、vSphere 和裸机在硬件上创建适当的机器实例。另外,对于 vSphere、VMC on AWS,您也可以在安装过程中自定义额外网络参数。

如果要重复使用广泛的云基础架构,可以完成用户置备的基础架构安装。使用这些安装,您可以在安装过程中手动部署集群所需的机器。如果在 AWS、Azure、Azure Stack Hub、GCP 或 VMC on AWS 上执行用户置备的基础架构安装,您可以使用提供的模板来帮助备份所有所需的组件。您还可以重复使用一个共享的 VPC on GCP。或者,您可以使用 供应商安装方法 将集群部署到其他云中。

您还可以在现有硬件上完成用户置备的基础架构安装。如果使用 RHOSP、RHOSP on SR-IOV、RHV、IBM Z 或 LinuxONE、使用 RHEL KVM 的 IBM Z 或 LinuxONE、IBM Power 或 vSphere,使用特定系统的安装说明来部署您的集群。如果您使用其他支持的硬件,请按照裸机安装过程进行操作。对于其中一些平台,如 RHOSP、vSphere、VMC on AWS 和 裸机,您也可以在安装过程中自定义额外网络参数。

2.1.4. 您的集群是否需要额外的安全性?

如果使用用户置备的安装方法,您可以为集群配置代理。这些说明包含在每个安装过程中。

如果要防止公共云中的集群从外部公开端点,您可以在 AWS、Azure 或 GCP 上使用安装程序置备的基础架构部署私有集群。

如果您需要安装对互联网有限访问的集群,如断开连接的或受限的网络集群,您可以镜像安装软件包并从中安装集群。在受限网络中使用用户置备的基础架构:AWS、GCP、IBM Z or LinuxONE、IBM Z or LinuxONE with RHEL KVM、IBM Power、vSphere、VMC on AWS 或裸机。您还可以按照 AWS、GCP、VMC on AWS、RHOSP、RHV 和 vSphere 上的详细说明,使用安装程序置备的基础架构将集群安装到受限网络中。

如果需要将集群部署到 AWS GovCloud 区域、AWS 中国区域或 Azure 政府区域,您可以在安装程序置备的基础架构安装过程中配置这些自定义区域。

您还可以将集群机器配置为在安装过程中使用 FIPS 验证的/Modules in Process 加密库。

只有在 x86_64 架构中的 OpenShift Container Platform 部署支持 FIPS 验证的/Modules in Process 加密库。

2.2. 安装后为用户准备集群

在安装集群时不需要进行一些配置,但建议在用户访问集群前进行操作。您可以通过自定义组成集群的 Operator,并将集群与其他所需系统(如身份提供程序)集成,从而自定义集群本身。

对于生产环境集群,您必须配置以下集成:

2.3. 为工作负载准备集群

根据工作负载需要,您可能需要在开始部署应用程序前执行额外的步骤。例如,在为应用程序构建策略准备了基础架构后,您可能需要为低延迟工作负载置备或保护敏感工作负载。您还可以为应用程序工作负载配置 监控。

如果您计划运行 Windows 工作负载,您必须在安装过程中启用 OVN-Kubernetes 的混合网络;安装集群后无法启用混合网络。

2.4. 支持的用于不同平台的安装方法

您可以在不同的平台上执行不同类型的安装。

不是所有安装选项都支持所有平台,如下表所示。勾选标记代表支持的选项,并链接到相关部分。

表 2.1. 安装程序置备的基础架构选项

第 3 章 断开连接的安装镜像

3.1. 关于断开连接的安装镜像

您可以使用镜像 registry 确保集群只使用满足机构对外部内容控制的容器镜像。在受限网络中置备的基础架构上安装集群前,您必须将所需的容器镜像镜像(mirror)到那个环境中。要镜像容器镜像,您必须有一个 registry 才能进行镜像(mirror)。

3.1.1. 创建镜像 registry

如果您已经有一个容器镜像 registry,如 Red Hat Quay,您可以使用它作为您的镜像 registry。如果您还没有 registry,可以使用 mirror registry for Red Hat OpenShift 创建镜像 registry。

3.1.2. 为断开连接的安装 mirror 镜像

您可以使用以下流程之一将 OpenShift Container Platform 镜像存储库镜像到您的镜像 registry:

3.2. 为 Red Hat OpenShift 创建带有 mirror registry 的 mirror registry

mirror registry for Red Hat OpenShift 是一个小型灵活的容器 registry,作为目标,用于为断开连接的安装镜像(mirror)的 OpenShift Container Platform 所需的容器镜像。

如果您已有容器镜像 registry(如 Red Hat Quay),您可以跳过本节并直接 镜像 OpenShift Container Platform 镜像存储库。

3.2.1. 先决条件

- OpenShift Container Platform 订阅。

- 安装了 Podman 3.3 和 OpenSSL 的 Red Hat Enterprise Linux (RHEL) 8 和 9。

- Red Hat Quay 服务的完全限定域名,它必须通过 DNS 服务器解析。

- 目标主机上的基于密钥的 SSH 连接。为本地安装自动生成 SSH 密钥。对于远程主机,您必须生成自己的 SSH 密钥。

- 2 个或更多 vCPU。

- 8 GB RAM。

OpenShift Container Platform 4.10 发行镜像大约需要 12 GB;OpenShift Container Platform 4.10 发行镜像和 OpenShift Container Platform 4.10 Red Hat Operator 镜像大约需要 358 GB。每个流推荐具有 1 TB 或更多空间。

重要这些要求基于本地测试结果,且只测试了发行镜像和 Operator 镜像。存储要求可能会因您的组织的需求而有所不同。例如,当镜像了多个 z-streams 时,则可能需要更多空间。您可以使用标准 Red Hat Quay 功能 或适当的 API 调用来删除不必要的镜像并释放空间。

3.2.2. Red Hat OpenShift 简介的镜像(mirror)registry

对于断开连接的 OpenShift Container Platform 部署,需要一个容器 registry 来安装集群。要在这样的集群中运行 production-grade registry 服务,您必须创建一个单独的 registry 部署来安装第一个集群。mirror registry for Red Hat OpenShift 可以解决这个问题,它包括在每个 OpenShift 订阅中。它可用于从 OpenShift 控制台 Downloads页面下载。

mirror registry for Red Hat OpenShift 允许用户使用 mirror-registry 命令行界面(CLI)工具安装一个较小的 Red Hat Quay 版本及其所需的组件。mirror registry for Red Hat OpenShift 会自动部署,它带有预先配置的本地存储和一个本地的数据库。它还包括自动生成的用户凭证和访问权限,其中只有一个输入集,且不需要额外配置选项。

mirror registry for Red Hat OpenShift 提供了一个预先确定的网络配置,并在成功时报告部署的组件凭证并访问 URL。另外还提供了一组有限的可选配置输入,如完全限定域名(FQDN)服务、超级用户名称和密码,以及自定义 TLS 证书。这为用户提供了一个容器 registry,以便在受限网络环境中运行 OpenShift Container Platform 时,轻松创建所有 OpenShift Container Platform 发行版本内容的离线镜像。

mirror registry for Red Hat OpenShift 仅限于托管安装断开连接的 OpenShift Container Platform 集群(如发行镜像或 Red Hat Operator 镜像)所需的镜像。它使用 Red Hat Enterprise Linux(RHEL)机器上的本地存储,而 RHEL 支持的存储也被 mirror registry for Red Hat OpenShift 支持。由客户创建的内容不应由 mirror registry for Red Hat OpenShift 托管。

与 Red Hat Quay 不同,mirror registry for Red Hat OpenShift 并不是一个高度可用的 registry,且只支持本地文件系统存储。对于多个集群的环境,不推荐使用 mirror registry for Red Hat OpenShift,因为有多个集群可以在更新集群时会存在单点故障。建议利用 mirror registry for Red Hat OpenShift 安装一个集群,通过这个集群托管一个生产环境级别的、具有高可用性的 registry(如 Red Hat Quay)的集群,用于为其他集群提供 OpenShift Container Platform 内容。

如果在安装环境中已有另一个容器 registry,则使用 mirror registry for Red Hat OpenShift 是可选的。

3.2.3. 使用 Red Hat OpenShift 的镜像 registry 在本地主机上镜像(mirror)

此流程解释了如何使用 mirror-registry 安装程序工具在本地主机上安装 mirror registry for Red Hat OpenShift。这样,用户可以创建在端口 443 上运行的本地主机 registry,以存储 OpenShift Container Platform 镜像的镜像。

使用 mirror-registry CLI 工具安装 mirror registry for Red Hat OpenShift 对您的系统会有一些变化。安装后,会创建一个 $HOME/quay-install 目录,其中包含安装文件、本地存储和配置捆绑包。如果部署目标是本地主机,则生成可信 SSH 密钥,并且设置主机计算机上的 systemd 文件,以确保容器运行时持久。另外,会创建一个名为 init 的初始用户,并自动生成的密码。所有访问凭证都会在安装例程的末尾打印。

流程

-

从 OpenShift console Downloads 页下载最新版本的 mirror registry for Red Hat OpenShift 的

mirror-registry.tar.gz软件包。 使用

mirror-registry工具,在本地主机上安装 mirror registry for Red Hat OpenShift。有关可用标志的完整列表,请参阅 "mirror registry for Red Hat OpenShift flags"。$ ./mirror-registry install \ --quayHostname <host_example_com> \ --quayRoot <example_directory_name>

运行以下命令,使用安装期间生成的用户名和密码登录 registry:

$ podman login -u init \ -p <password> \ <host_example_com>:8443> \ --tls-verify=false 1- 1

- 您可以通过将您的系统配置为信任生成的 rootCA 证书来避免运行

--tls-verify=false。如需更多信息,请参阅"使用 SSL 保护到 Red Hat Quay 的连接"和"配置系统以信任证书认证机构"。

注意您还可以在安装后通过

https://<host.example.com>:8443访问 UI 登录。您可以在登录后镜像 OpenShift Container Platform 镜像。根据您的需要,请参阅本文档的"镜像 OpenShift Container Platform 镜像存储库"或"镜像 Operator 目录"部分以用于此文档。

注意如果因为存储层问题导致 Red Hat OpenShift 镜像存储了镜像 registry 存在问题,您可以在更稳定的存储上对 OpenShift Container Platform 镜像重新镜像(mirror)或重新安装 registry。

3.2.4. 从一个本地主机为 Red Hat OpenShift 更新 mirror registry

此流程解释了如何使用 upgrade 命令从本地主机更新 Red Hat OpenShift 的镜像 registry。更新至最新版本可确保新的功能、错误修复和安全漏洞修复。

更新时,镜像 registry 会发生间歇性停机时间,因为它在更新过程中重启。

先决条件

- 您已在本地主机上安装了 Red Hat OpenShift 的镜像 registry。

流程

如果要将 mirror registry for Red Hat OpenShift 从 1.2.z 升级到 1.3.0,您的安装目录默认为

/etc/quay-install,您可以输入以下命令:$ sudo ./mirror-registry upgrade -v

注意-

mirror registry for Red Hat OpenShift 将 Quay 的 Podman 卷、Postgres 数据和

/etc/quay-install数据迁移到新的$HOME/quay-install位置。这可让让您在以后的升级过程中,在没有--quayRoot标志的情况下,使用 mirror registry for Red Hat OpenShift。 -

在使用

./mirror-registry upgrade -v标记升级 mirror registry for Red Hat OpenShift 时需要包括在创建 mirror registry 时使用的相同的凭证。例如,如果使用--quayHostname <host_example_com>和--quayRoot <example_directory_name>安装 Red Hat OpenShift 镜像 registry,则必须包括该字符串来正确地升级镜像 registry。

-

mirror registry for Red Hat OpenShift 将 Quay 的 Podman 卷、Postgres 数据和

如果您要将 mirror registry for Red Hat OpenShift 从 1.2.z 升级到 1.3.0,且您在 1.2.z 部署中使用了指定目录,则必须传递新的

--pgStorage' 和 '--quayStorage标志。例如:$ sudo ./mirror-registry upgrade --quayHostname <host_example_com> --quayRoot <example_directory_name> --pgStorage <example_directory_name>/pg-data --quayStorage <example_directory_name>/quay-storage -v

3.2.5. 使用 Red Hat OpenShift 的镜像 registry 在远程主机上镜像(mirror)

此流程解释了如何使用 mirror-registry 工具在远程主机上安装 mirror registry for Red Hat OpenShift。这样,用户可以创建 registry 来保存 OpenShift Container Platform 镜像的镜像。

使用 mirror-registry CLI 工具安装 mirror registry for Red Hat OpenShift 对您的系统会有一些变化。安装后,会创建一个 $HOME/quay-install 目录,其中包含安装文件、本地存储和配置捆绑包。如果部署目标是本地主机,则生成可信 SSH 密钥,并且设置主机计算机上的 systemd 文件,以确保容器运行时持久。另外,会创建一个名为 init 的初始用户,并自动生成的密码。所有访问凭证都会在安装例程的末尾打印。

流程

-

从 OpenShift console Downloads 页下载最新版本的 mirror registry for Red Hat OpenShift 的

mirror-registry.tar.gz软件包。 使用

mirror-registry工具,在本地主机上安装 mirror registry for Red Hat OpenShift。有关可用标志的完整列表,请参阅 "mirror registry for Red Hat OpenShift flags"。$ ./mirror-registry install -v \ --targetHostname <host_example_com> \ --targetUsername <example_user> \ -k ~/.ssh/my_ssh_key \ --quayHostname <host_example_com> \ --quayRoot <example_directory_name>

运行以下命令,使用安装期间生成的用户名和密码登录 到镜像的 registry:

$ podman login -u init \ -p <password> \ <host_example_com>:8443> \ --tls-verify=false 1- 1

- 您可以通过将您的系统配置为信任生成的 rootCA 证书来避免运行

--tls-verify=false。如需更多信息,请参阅"使用 SSL 保护到 Red Hat Quay 的连接"和"配置系统以信任证书认证机构"。

注意您还可以在安装后通过

https://<host.example.com>:8443访问 UI 登录。您可以在登录后镜像 OpenShift Container Platform 镜像。根据您的需要,请参阅本文档的"镜像 OpenShift Container Platform 镜像存储库"或"镜像 Operator 目录"部分以用于此文档。

注意如果因为存储层问题导致 Red Hat OpenShift 镜像存储了镜像 registry 存在问题,您可以在更稳定的存储上对 OpenShift Container Platform 镜像重新镜像(mirror)或重新安装 registry。

3.2.6. 从一个远程主机为 Red Hat OpenShift 更新 mirror registry

此流程解释了如何使用 upgrade 命令从远程主机更新 Red Hat OpenShift 的镜像 registry。更新至最新版本可确保程序错误修复和安全漏洞。

更新时,镜像 registry 会发生间歇性停机时间,因为它在更新过程中重启。

先决条件

- 您已在远程主机上安装了 Red Hat OpenShift 的镜像 registry。

流程

要从远程主机升级 Red Hat OpenShift 的镜像 registry,请输入以下命令:

$ ./mirror-registry upgrade -v --targetHostname <remote_host_url> --targetUsername <user_name> -k ~/.ssh/my_ssh_key

注意在使用

./mirror-registry upgrade -v标记升级 mirror registry for Red Hat OpenShift 时需要包括在创建 mirror registry 时使用的相同的凭证。例如,如果使用--quayHostname <host_example_com>和--quayRoot <example_directory_name>安装 Red Hat OpenShift 镜像 registry,则必须包括该字符串来正确地升级镜像 registry。

3.2.7. 为 Red Hat OpenShift 卸载镜像 registry

您可以运行以下命令来从本地主机中卸载 mirror registry for Red Hat OpenShift:

$ ./mirror-registry uninstall -v \ --quayRoot <example_directory_name>

注意-

删除 mirror registry for Red Hat OpenShift 会在删除前提示用户。您可以使用

--autoApprove来跳过此提示。 -

如果使用

--quayRoot标志安装了 mirror registry for Red Hat OpenShift,则卸载时也需要使用--quayRoot标志。例如,如果使用--quayRoot example_directory_name安装了 mirror registry for Red Hat OpenShift,则在卸载镜像 registry 时也需要包括这个字符串才能正确卸载。

-

删除 mirror registry for Red Hat OpenShift 会在删除前提示用户。您可以使用

3.2.8. Mirror registry for Red Hat OpenShift 标记

以下标记可用于 mirror registry for Red Hat OpenShift :

| 标记 | 描述 |

|---|---|

|

|

禁用交互式提示的布尔值。如果设置为 |

|

| 在 Quay 安装过程中创建的 init 用户的密码。必须至少包含八个字符,且不包含空格。 |

|

|

显示初始用户的用户名。若未指定,则默认为 |

|

| 允许用户禁用颜色序列,在运行安装、卸载和升级命令时将其传播到 Ansible。 |

|

|

保存 Postgres 持久性存储数据的文件夹。默认为 |

|

|

客户端用来联系 registry 的镜像 registry 的完全限定域名。等同于 Quay |

|

|

保存 Quay 持久性存储数据的文件夹。默认为 |

|

|

保存容器镜像层和配置数据的目录,包括 |

|

|

SSH 身份密钥的路径。如果未指定,则默认为 |

|

|

SSL/TLS 公钥/证书的路径。默认为 |

|

|

跳过对 |

|

|

用于 HTTPS 通信的 SSL/TLS 私钥路径。默认为 |

|

|

要安装 Quay 的目标的主机名。默认为 |

|

|

目标主机上的用户,将用于 SSH。默认为 |

|

| 显示调试日志和 Ansible playbook 输出。 |

|

| 显示 mirror registry for Red Hat OpenShift 的版本。 |

-

如果您的系统的公共 DNS 名称与本地主机名不同,则必须修改

--quayHostname。另外,--quayHostname标志不支持使用 IP 地址的安装。需要使用主机名进行安装。 -

当镜像 registry 在代理后面设置时,会使用

--sslCheckSkip,并且公开的主机名与内部 Quay 主机名不同。当用户不希望在安装过程中对提供的 Quay 主机名验证证书时,也可以使用它。

3.2.9. Mirror registry for Red Hat OpenShift 发现注记

mirror registry for Red Hat OpenShift 是一个小型灵活的容器 registry,作为目标,用于为断开连接的安装镜像(mirror)的 OpenShift Container Platform 所需的容器镜像。

本发行注记介绍了 OpenShift Container Platform 的 mirror registry for Red Hat OpenShift。

如需了解 mirror registry for Red Hat OpenShift,请参阅 Creating a mirror registry with mirror registry for Red Hat OpenShift。

3.2.9.1. Mirror registry for Red Hat OpenShift 1.3.8

发布日期:2023 年 8 月 16 日

Mirror registry for Red Hat OpenShift 现在包括在 Red Hat Quay 3.8.11 中。

以下公告适用于 mirror registry for Red Hat OpenShift:

3.2.9.2. Mirror registry for Red Hat OpenShift 1.3.7

发布日期:2023 年 7 月 19 日

Mirror registry for Red Hat OpenShift 现在包括在 Red Hat Quay 3.8.10 中。

以下公告适用于 mirror registry for Red Hat OpenShift:

3.2.9.3. Mirror registry for Red Hat OpenShift 1.3.6

发布日期:2023 年 5 月 30 日

Mirror registry for Red Hat OpenShift 现在包括在 Red Hat Quay 3.8.8 中。

以下公告适用于 mirror registry for Red Hat OpenShift:

3.2.9.4. Mirror registry for Red Hat OpenShift 1.3.5

发布日期:2023 年 5 月 18 日

Mirror registry for Red Hat OpenShift 现在包括在 Red Hat Quay 3.8.7 中。

以下公告适用于 mirror registry for Red Hat OpenShift:

3.2.9.5. Mirror registry for Red Hat OpenShift 1.3.4

发布日期:2023 年 4 月 25 日

Mirror registry for Red Hat OpenShift 现在包括在 Red Hat Quay 3.8.6 中。

以下公告适用于 mirror registry for Red Hat OpenShift:

3.2.9.6. Mirror registry for Red Hat OpenShift 1.3.3

发布日期:2023 年 4 月 5 日

Mirror registry for Red Hat OpenShift 现在包括在 Red Hat Quay 3.8.5 中。

以下公告适用于 mirror registry for Red Hat OpenShift:

3.2.9.7. Mirror registry for Red Hat OpenShift 1.3.2

发布日期:2023 年 3 月 21 日

Mirror registry for Red Hat OpenShift 现在包括在 Red Hat Quay 3.8.4 中。

以下公告适用于 mirror registry for Red Hat OpenShift:

3.2.9.8. Mirror registry for Red Hat OpenShift 1.3.1

发布日期:2023 年 3 月 7 日

Mirror registry for Red Hat OpenShift 现在包括在 Red Hat Quay 3.8.3 中。

以下公告适用于 mirror registry for Red Hat OpenShift:

3.2.9.9. Mirror registry for Red Hat OpenShift 1.3.0

发布日期:2023 年 2 月 20 日

Mirror registry for Red Hat OpenShift 现在包括在 Red Hat Quay 3.8.1 中。

以下公告适用于 mirror registry for Red Hat OpenShift:

3.2.9.9.1. 新功能

- Mirror registry for Red Hat OpenShift 现在支持在 Red Hat Enterprise Linux (RHEL) 9 安装中。

现在,mirror registry for Red Hat OpenShift 本地主机安装提供了 IPv6 支持。

目前, mirror registry for Red Hat OpenShift 远程主机安装不支持 IPv6。

-

添加了新功能标志

--quayStorage。使用这个标志,具有 root 特权的用户可以手动设置其 Quay 持久性存储的位置。 -

添加了新功能标志

--pgStorage。使用这个标志,具有 root 特权的用户可以手动设置其 Postgres 持久性存储的位置。 在以前的版本中,用户需要具有 root 权限 (

sudo) 才能安装 mirror registry for Red Hat OpenShift。在这个版本中,安装 mirror registry for Red Hat OpenShift 不再需要sudo。当使用

sudo安装 mirror registry for Red Hat OpenShift 时,会创建一个包含安装文件、本地存储和配置捆绑包的/etc/quay-install目录。移除对sudo的要求后,安装文件和配置捆绑包现在安装到$HOME/quay-install中。本地存储(如 Postgres 和 Quay)现在由 Podman 自动创建的命名卷中。要覆盖存储这些文件的默认目录,您可以为 mirror registry for Red Hat OpenShift 使用命令行参数。如需有关 mirror registry for Red Hat OpenShift 命令行参数的更多信息,请参阅"Mirror registry for Red Hat OpenShift 标志"。

3.2.9.9.2. 程序错误修复

-

在以前的版本中,当试图卸载 mirror registry for Red Hat OpenShift 时会返回以下错误:

["Error: no container with name or ID \"quay-postgres\" found: no such container"], "stdout": "", "stdout_lines": []*。在这个版本中,mirror registry for Red Hat OpenShift 服务的停止和卸载的顺序有所变化,因此在卸载 mirror registry for Red Hat OpenShift 时不再发生错误。如需更多信息,请参阅 PROJQUAY-4629。

3.2.9.10. Mirror registry for Red Hat OpenShift 1.2.9

Mirror registry for Red Hat OpenShift 现在包括在 Red Hat Quay 3.7.10 中。

以下公告适用于 mirror registry for Red Hat OpenShift:

3.2.9.11. Mirror registry for Red Hat OpenShift 1.2.8

Mirror registry for Red Hat OpenShift 现在包括在 Red Hat Quay 3.7.9 中。

以下公告适用于 mirror registry for Red Hat OpenShift:

3.2.9.12. Mirror registry for Red Hat OpenShift 1.2.7

限制,Red Hat Quay 3.7.8 提供了 Mirror registry for Red Hat OpenShift。

以下公告适用于 mirror registry for Red Hat OpenShift:

3.2.9.12.1. 程序错误修复

-

在以前的版本中,

getFQDN()依赖于完全限定域名 (FQDN) 库来确定其 FQDN,FQDN 库会尝试直接读取/etc/hosts文件夹。因此,在一些带有不常见的 DNS 配置的 Red Hat Enterprise Linux CoreOS (RHCOS) 安装中,FQDN 库将无法安装并导致安装过程被终止。在这个版本中,mirror registry for Red Hat OpenShift 使用hostname来决定 FQDN。因此,FQDN 库不会导致安装被中止。(PROJQUAY-4139)

3.2.9.13. Mirror registry for Red Hat OpenShift 1.2.6

Mirror registry for Red Hat OpenShift 现在包括在 Red Hat Quay 3.7.7 中。

以下公告适用于 mirror registry for Red Hat OpenShift:

3.2.9.13.1. 新功能

添加了新功能标志 --no-color (-c)。通过此功能标志,用户可以禁用颜色序列,在运行安装、卸载和升级命令时将其传播到 Ansible。

3.2.9.14. Mirror registry for Red Hat OpenShift 1.2.5

Mirror registry for Red Hat OpenShift 现在包括在 Red Hat Quay 3.7.6 中。

以下公告适用于 mirror registry for Red Hat OpenShift:

3.2.9.15. Mirror registry for Red Hat OpenShift 1.2.4

Mirror registry for Red Hat OpenShift 现在包括在 Red Hat Quay 3.7.5 中。

以下公告适用于 mirror registry for Red Hat OpenShift:

3.2.9.16. Mirror registry for Red Hat OpenShift 1.2.3

Mirror registry for Red Hat OpenShift 现在包括在 Red Hat Quay 3.7.4 中。

以下公告适用于 mirror registry for Red Hat OpenShift:

3.2.9.17. Mirror registry for Red Hat OpenShift 1.2.2

Mirror registry for Red Hat OpenShift 现在包括在 Red Hat Quay 3.7.3 中。

以下公告适用于 mirror registry for Red Hat OpenShift:

3.2.9.18. Mirror registry for Red Hat OpenShift 1.2.1

Mirror registry for Red Hat OpenShift 现在包括在 Red Hat Quay 3.7.2 中。

以下公告适用于 mirror registry for Red Hat OpenShift:

3.2.9.19. Mirror registry for Red Hat OpenShift 1.2.0

Mirror registry for Red Hat OpenShift 现在包括在 Red Hat Quay 3.7.1 中。

以下公告适用于 mirror registry for Red Hat OpenShift:

3.2.9.19.1. 程序错误修复

-

在以前的版本中,在 Quay pod Operator 内运行的所有组件和 worker 都被设置为

DEBUG。因此,在创建大量流量日志时使用了不必要的空间。在这个版本中,日志级别被设置为WARN,这可减少流量信息,同时突出了问题的情况。(PROJQUAY-3504)

3.2.9.20. Mirror registry for Red Hat OpenShift 1.1.0

以下公告适用于 mirror registry for Red Hat OpenShift:

3.2.9.20.1. 新功能

添加了一个新的命令

mirror-registry upgrade。此命令升级所有容器镜像,而不会干扰配置或数据。注意如果

quayRoot之前设为默认值以外的内容,则必须将其传递到 upgrade 命令。

3.2.9.20.2. 程序错误修复

-

在以前的版本中,没有

quayHostname或targetHostname默认为本地主机名。在这个版本中,如果缺少quayHostname和targetHostname,则将其默认为本地主机名。(PROJQUAY-3079) -

在以前的版本中,命令

./mirror-registry --version返回一个unknown flag错误。现在,运行./mirror-registry --version会返回 mirror registry for Red Hat OpenShift 的当前版本。(PROJQUAY-3086) -

在以前的版本中,用户无法在安装过程中设置密码,例如在运行

./mirror-registry install --initUser <user_name> --initPassword <password> --verbose时。在这个版本中,用户可以在安装过程中设置密码。(PROJQUAY-3149) - 在以前的版本中,如果已销毁,则 mirror registry for Red Hat OpenShift 不会重新创建 pod。现在,如果 pod 被销毁,则会重新创建 pod。(PROJQUAY-3261)

3.2.10. Mirror registry for Red Hat OpenShift 故障排除

为了更好地对 mirror registry for Red Hat OpenShift 进行故障排除,您可以收集由镜像 registry 安装的 systemd 服务的日志。安装以下服务:

- quay-app.service

- quay-postgres.service

- quay-redis.service

- quay-pod.service

先决条件

- 您已安装了 mirror registry for Red Hat OpenShift。

流程

如果使用 root 权限安装 mirror registry for Red Hat OpenShift,您可以输入以下命令获取其 systemd 服务的状态信息:

$ sudo systemctl status <service>

如果作为标准用户安装 mirror registry for Red Hat OpenShift,您可以输入以下命令获取其 systemd 服务的状态信息:

$ systemctl --user status <service>

3.3. 为断开连接的安装 mirror 镜像

您可以确保集群只使用满足您机构对外部内容控制的容器镜像。在受限网络中置备的基础架构上安装集群前,您必须将所需的容器镜像镜像(mirror)到那个环境中。要镜像容器镜像,您必须有一个 registry 才能进行镜像(mirror)。

您必须可以访问互联网来获取所需的容器镜像。在这一流程中,您要将镜像 registry 放在可访问您的网络以及互联网的镜像(mirror)主机上。如果您没有镜像主机的访问权限,请使用镜像 Operator 目录与断开连接的集群流程一起使用,将镜像复制到可跨网络界限的设备。

3.3.1. 先决条件

您必须在托管 OpenShift Container Platform 集群的位置(如以下 registry 之一)中有一个支持 Docker v2-2 的容器镜像 registry:

如果您有 Red Hat Quay 权利,请参阅有关部署 Red Hat Quay 以了解概念验证的文档,或使用 Quay Operator。如果您需要额外的帮助来选择并安装 registry,请联络您的销售代表或红帽支持。

- 如果您还没有容器镜像 registry,OpenShift Container Platform 可以为订阅者提供一个 mirror registry for Red Hat OpenShift。Red Hat OpenShift 的镜像 registry 包含在您的订阅中,它是一个小型容器 registry,可用于在断开连接的安装中镜像 OpenShift Container Platform 所需的容器镜像。

3.3.2. 关于镜像 registry

您可以镜像 OpenShift Container Platform 安装所需的镜像,以及容器镜像 registry 的后续产品更新,如 Red Hat Quay、JFrog Artifactory、Sonatype Nexus Repository 或 Harbor。如果您无法访问大型容器 registry,可以使用 mirror registry for Red Hat OpenShift,它是包括在 OpenShift Container Platform 订阅中的一个小型容器 registry。

您可以使用支持 Docker v2-2 的任何容器 registry,如 Red Hat Quay, mirror registry for Red Hat OpenShift, Artifactory, Sonatype Nexus Repository, 或 Harbor。无论您所选 registry 是什么,都会将互联网上红帽托管站点的内容镜像到隔离的镜像 registry 相同。镜像内容后,您要将每个集群配置为从镜像 registry 中检索此内容。

OpenShift 镜像 registry 不能用作目标 registry,因为它不支持没有标签的推送,在镜像过程中需要这个推送。

如果选择的容器 registry 不是 mirror registry for Red Hat OpenShift,则需要集群中置备的每台机器都可以访问它。如果 registry 无法访问,安装、更新或常规操作(如工作负载重新定位)可能会失败。因此,您必须以高度可用的方式运行镜像 registry,镜像 registry 至少必须与 OpenShift Container Platform 集群的生产环境可用性相匹配。

使用 OpenShift Container Platform 镜像填充镜像 registry 时,可以遵循以下两种情况。如果您的主机可以同时访问互联网和您的镜像 registry,而不能访问您的集群节点,您可以直接从该机器中镜像该内容。这个过程被称为 连接的镜像(mirror)。如果没有这样的主机,则必须将该镜像文件镜像到文件系统中,然后将该主机或者可移动介质放入受限环境中。这个过程被称为 断开连接的镜像。

对于已镜像的 registry,若要查看拉取镜像的来源,您必须查看 Trying 以访问 CRI-O 日志中的日志条目。查看镜像拉取源的其他方法(如在节点上使用 crictl images 命令)显示非镜像镜像名称,即使镜像是从镜像位置拉取的。

红帽没有针对 OpenShift Container Platform 测试第三方 registry。

附加信息

有关查看 CRI-O 日志以查看镜像源的详情,请参阅查看镜像拉取源。

3.3.3. 准备您的镜像主机

执行镜像步骤前,必须准备主机以检索内容并将其推送到远程位置。

3.3.3.1. 通过下载二进制文件安装 OpenShift CLI

您可以安装 OpenShift CLI(oc)来使用命令行界面与 OpenShift Container Platform 进行交互。您可以在 Linux、Windows 或 macOS 上安装 oc。

如果安装了旧版本的 oc,则无法使用 OpenShift Container Platform 4.10 中的所有命令。下载并安装新版本的 oc。

在 Linux 上安装 OpenShift CLI

您可以按照以下流程在 Linux 上安装 OpenShift CLI(oc)二进制文件。

流程

- 导航到红帽客户门户网站上的 OpenShift Container Platform 下载页面。

- 在 Version 下拉菜单中选择相应的版本。

- 点 OpenShift v4.10 Linux Client 条目旁的 Download Now 来保存文件。

解包存档:

$ tar xvf <file>

将

oc二进制文件放到PATH 中的目录中。要查看您的

PATH,请执行以下命令:$ echo $PATH

安装 OpenShift CLI 后,可以使用 oc 命令:

$ oc <command>

在 Windows 上安装 OpenShift CLI

您可以按照以下流程在 Windows 上安装 OpenShift CLI(oc)二进制文件。

流程

- 导航到红帽客户门户网站上的 OpenShift Container Platform 下载页面。

- 在 Version 下拉菜单中选择相应的版本。

- 点 OpenShift v4.10 Windows Client 条目旁的 Download Now 来保存文件。

- 使用 ZIP 程序解压存档。

将

oc二进制文件移到PATH 中的目录中。要查看您的

PATH,请打开命令提示并执行以下命令:C:\> path

安装 OpenShift CLI 后,可以使用 oc 命令:

C:\> oc <command>

在 macOS 上安装 OpenShift CLI

您可以按照以下流程在 macOS 上安装 OpenShift CLI(oc)二进制文件。

流程

- 导航到红帽客户门户网站上的 OpenShift Container Platform 下载页面。

- 在 Version 下拉菜单中选择相应的版本。

- 点 OpenShift v4.10 MacOSX Client 条目旁的 Download Now 来保存文件。

- 解包和解压存档。

将

oc二进制文件移到 PATH 的目录中。要查看您的

PATH,请打开终端并执行以下命令:$ echo $PATH

安装 OpenShift CLI 后,可以使用 oc 命令:

$ oc <command>

3.3.4. 配置允许对容器镜像进行镜像的凭证

创建容器镜像 registry 凭证文件,允许将红帽的镜像镜像到您的镜像环境中。

安装集群时不要使用此镜像 registry 凭据文件作为 pull secret。如果在安装集群时提供此文件,集群中的所有机器都将具有镜像 registry 的写入权限。

此过程需要您可以对镜像 registry 上的容器镜像 registry 进行写操作,并将凭证添加到 registry pull secret。

先决条件

- 您已将镜像 registry 配置为在断开连接的环境中使用。

- 您在镜像 registry 中标识了镜像仓库的位置,以将容器镜像镜像(mirror)到这个位置。

- 您置备了一个镜像 registry 帐户,允许将镜像上传到该镜像仓库。

流程

在安装主机上完成以下步骤:

-

下载您的

registry.redhat.iopull secret(从Red Hat OpenShift Cluster Manager)。 以 JSON 格式创建您的 pull secret 副本:

$ cat ./pull-secret | jq . > <path>/<pull_secret_file_in_json> 1- 1

- 指定到存储 pull secret 的文件夹的路径,以及您创建的 JSON 文件的名称。

该文件类似于以下示例:

{ "auths": { "cloud.openshift.com": { "auth": "b3BlbnNo...", "email": "you@example.com" }, "quay.io": { "auth": "b3BlbnNo...", "email": "you@example.com" }, "registry.connect.redhat.com": { "auth": "NTE3Njg5Nj...", "email": "you@example.com" }, "registry.redhat.io": { "auth": "NTE3Njg5Nj...", "email": "you@example.com" } } }为您的镜像 registry 生成 base64 编码的用户名和密码或令牌:

$ echo -n '<user_name>:<password>' | base64 -w0 1 BGVtbYk3ZHAtqXs=- 1

- 通过

<user_name>和<password>指定 registry 的用户名和密码。

编辑 JSON 文件并添加描述 registry 的部分:

"auths": { "<mirror_registry>": { 1 "auth": "<credentials>", 2 "email": "you@example.com" } },该文件类似于以下示例:

{ "auths": { "registry.example.com": { "auth": "BGVtbYk3ZHAtqXs=", "email": "you@example.com" }, "cloud.openshift.com": { "auth": "b3BlbnNo...", "email": "you@example.com" }, "quay.io": { "auth": "b3BlbnNo...", "email": "you@example.com" }, "registry.connect.redhat.com": { "auth": "NTE3Njg5Nj...", "email": "you@example.com" }, "registry.redhat.io": { "auth": "NTE3Njg5Nj...", "email": "you@example.com" } } }

3.3.5. 镜像 OpenShift Container Platform 镜像存储库

镜像要在集群安装或升级过程中使用的 OpenShift Container Platform 镜像仓库。

先决条件

- 您的镜像主机可访问互联网。

- 您已将镜像 registry 配置为在受限网络中使用,并可访问您配置的证书和凭证。

- 您已从 Red Hat OpenShift Cluster Manager 下载了 pull secret,并已修改为包含镜像存储库身份验证信息。

- 如果您使用自签名证书,已在证书中指定 Subject Alternative Name。

流程

在镜像主机上完成以下步骤:

- 查看 OpenShift Container Platform 下载页面,以确定您要安装的 OpenShift Container Platform 版本,并决定 Repository Tags 页中的相应标签(tag)。

设置所需的环境变量:

导出发行版本信息:

$ OCP_RELEASE=<release_version>

对于

<release_version>,请指定与 OpenShift Container Platform 版本对应的标签,用于您的架构,如4.5.4。导出本地 registry 名称和主机端口:

$ LOCAL_REGISTRY='<local_registry_host_name>:<local_registry_host_port>'

对于

<local_registry_host_name>,请指定镜像存储库的 registry 域名;对于<local_registry_host_port>,请指定用于提供内容的端口。导出本地存储库名称:

$ LOCAL_REPOSITORY='<local_repository_name>'

对于

<local_repository_name>,请指定要在 registry 中创建的仓库名称,如ocp4/openshift4。导出要进行镜像的存储库名称:

$ PRODUCT_REPO='openshift-release-dev'

对于生产环境版本,必须指定

openshift-release-dev。导出 registry pull secret 的路径:

$ LOCAL_SECRET_JSON='<path_to_pull_secret>'

对于

<path_to_pull_secret>,请指定您创建的镜像 registry 的 pull secret 的绝对路径和文件名。导出发行版本镜像:

$ RELEASE_NAME="ocp-release"

对于生产环境版本,您必须指定

ocp-release。为您的服务器导出构架类型,如

x86_64:$ ARCHITECTURE=<server_architecture>

导出托管镜像的目录的路径:

$ REMOVABLE_MEDIA_PATH=<path> 1- 1

- 指定完整路径,包括开始的前斜杠(/)字符。

将版本镜像(mirror)到镜像 registry:

如果您的镜像主机无法访问互联网,请执行以下操作:

- 将可移动介质连接到连接到互联网的系统。

查看要镜像的镜像和配置清单:

$ oc adm release mirror -a ${LOCAL_SECRET_JSON} \ --from=quay.io/${PRODUCT_REPO}/${RELEASE_NAME}:${OCP_RELEASE}-${ARCHITECTURE} \ --to=${LOCAL_REGISTRY}/${LOCAL_REPOSITORY} \ --to-release-image=${LOCAL_REGISTRY}/${LOCAL_REPOSITORY}:${OCP_RELEASE}-${ARCHITECTURE} --dry-run-

记录上一命令输出中的

imageContentSources部分。您的镜像信息与您的镜像存储库相对应,您必须在安装过程中将imageContentSources部分添加到install-config.yaml文件中。 将镜像镜像到可移动介质的目录中:

$ oc adm release mirror -a ${LOCAL_SECRET_JSON} --to-dir=${REMOVABLE_MEDIA_PATH}/mirror quay.io/${PRODUCT_REPO}/${RELEASE_NAME}:${OCP_RELEASE}-${ARCHITECTURE}将介质上传到受限网络环境中,并将镜像上传到本地容器 registry。

$ oc image mirror -a ${LOCAL_SECRET_JSON} --from-dir=${REMOVABLE_MEDIA_PATH}/mirror "file://openshift/release:${OCP_RELEASE}*" ${LOCAL_REGISTRY}/${LOCAL_REPOSITORY} 1- 1

- 对于

REMOVABLE_MEDIA_PATH,您必须使用与镜像镜像时指定的同一路径。

重要运行

oc image mirror可能会导致以下错误:error: unable to retrieve source image。当镜像索引包括对镜像 registry 中不再存在的镜像的引用时,会发生此错误。镜像索引可能会保留旧的引用,以便为运行这些镜像的用户在升级图表中显示新的升级路径。作为临时解决方案,您可以使用--skip-missing选项绕过错误并继续下载镜像索引。如需更多信息,请参阅 Service Mesh Operator 镜像失败。

如果本地容器 registry 连接到镜像主机,请执行以下操作:

使用以下命令直接将发行版镜像推送到本地 registry:

$ oc adm release mirror -a ${LOCAL_SECRET_JSON} \ --from=quay.io/${PRODUCT_REPO}/${RELEASE_NAME}:${OCP_RELEASE}-${ARCHITECTURE} \ --to=${LOCAL_REGISTRY}/${LOCAL_REPOSITORY} \ --to-release-image=${LOCAL_REGISTRY}/${LOCAL_REPOSITORY}:${OCP_RELEASE}-${ARCHITECTURE}该命令将发行信息提取为摘要,其输出包括安装集群时所需的

imageContentSources数据。记录上一命令输出中的

imageContentSources部分。您的镜像信息与您的镜像存储库相对应,您必须在安装过程中将imageContentSources部分添加到install-config.yaml文件中。注意镜像名称在镜像过程中被修补到 Quay.io, podman 镜像将在 bootstrap 虚拟机的 registry 中显示 Quay.io。

要创建基于您镜像内容的安装程序,请提取内容并将其固定到发行版中:

如果您的镜像主机无法访问互联网,请运行以下命令:

$ oc adm release extract -a ${LOCAL_SECRET_JSON} --icsp-file=<file> \ --command=openshift-install "${LOCAL_REGISTRY}/${LOCAL_REPOSITORY}:${OCP_RELEASE}"如果本地容器 registry 连接到镜像主机,请运行以下命令:

$ oc adm release extract -a ${LOCAL_SECRET_JSON} --command=openshift-install "${LOCAL_REGISTRY}/${LOCAL_REPOSITORY}:${OCP_RELEASE}-${ARCHITECTURE}"重要要确保将正确的镜像用于您选择的 OpenShift Container Platform 版本,您必须从镜像内容中提取安装程序。

您必须在有活跃互联网连接的机器上执行这个步骤。

对于使用安装程序置备的基础架构的集群,运行以下命令:

$ openshift-install

3.3.6. 在断开连接的环境中的 Cluster Samples Operator

在断开连接的环境中,在安装集群后执行额外的步骤来配置 Cluster Samples Operator。在准备过程中查阅以下信息:

3.3.6.1. 协助镜像的 Cluster Samples Operator

在安装过程中,OpenShift Container Platform 在 openshift-cluster-samples-operator 命名空间中创建一个名为 imagestreamtag-to-image 的配置映射。imagestreamtag-to-image 配置映射包含每个镜像流标签的条目(填充镜像)。

配置映射中 data 字段中每个条目的键格式为 <image_stream_name>_<image_stream_tag_name>。

在断开连接的 OpenShift Container Platform 安装过程中,Cluster Samples Operator 的状态被设置为 Removed。如果您将其改为 Managed,它会安装示例。

在网络限制或断开连接的环境中使用示例可能需要通过网络访问服务。某些示例服务包括:Github、Maven Central、npm、RubyGems、PyPi 等。这可能需要执行额外的步骤,让集群 samples operator 对象能够访问它们所需的服务。

您可以使用此配置映射作为导入镜像流所需的镜像的引用。

-

在 Cluster Samples Operator 被设置为

Removed时,您可以创建镜像的 registry,或决定您要使用哪些现有镜像 registry。 - 使用新的配置映射作为指南来镜像您要镜像的 registry 的示例。

-

将没有镜像的任何镜像流添加到 Cluster Samples Operator 配置对象的

skippedImagestreams列表中。 -

将 Cluster Samples Operator 配置对象的

samplesRegistry设置为已镜像的 registry。 -

然后,将 Cluster Samples Operator 设置为

Managed来安装您已镜像的镜像流。

3.3.7. 镜像用于断开连接的集群的 Operator 目录

您可以使用 oc adm catalog mirror 命令将红帽提供的目录或自定义目录的 Operator 内容镜像到容器镜像 registry 中。目标 registry 必须支持 Docker v2-2。对于受限网络中的集群,此 registry 可以是集群有网络访问权限的 registry,如在受限网络集群安装过程中创建的镜像 registry。

- OpenShift 镜像 registry 不能用作目标 registry,因为它不支持没有标签的推送,在镜像过程中需要这个推送。

-

运行

oc adm catalog mirror可能会导致以下错误:error: unable to retrieve source image。当镜像索引包括对镜像 registry 中不再存在的镜像的引用时,会发生此错误。镜像索引可能会保留旧的引用,以便为运行这些镜像的用户在升级图表中显示新的升级路径。作为临时解决方案,您可以使用--skip-missing选项绕过错误并继续下载镜像索引。如需更多信息,请参阅 Service Mesh Operator 镜像失败。

oc adm catalog mirror 命令还会自动将在镜像过程中指定的索引镜像(无论是红帽提供的索引镜像还是您自己的自定义构建索引镜像)镜像到目标 registry。然后,您可以使用镜像的索引镜像创建一个目录源,允许 Operator Lifecycle Manager(OLM)将镜像目录加载到 OpenShift Container Platform 集群。

3.3.7.1. 先决条件

与断开连接的集群一起使用的 Operator 目录具有以下先决条件:

- 没有网络访问限制的工作站

-

podman1.9.3 或更高版本。 如果要过滤或 prune 默认目录,且仅选择性地镜像部分 Operator,请参阅以下部分:

如果要镜像红帽提供的目录,请在具有无网络访问限制的工作站中运行以下命令,以便与

registry.redhat.io进行身份验证:$ podman login registry.redhat.io

- 访问支持 Docker v22 的镜像 registry。

-

在镜像 registry 上,决定使用哪个存储库或命名空间来存储已镜像的 Operator 内容。例如,您可以创建一个

olm-mirror存储库。 - 如果您的镜像 registry 无法访问互联网,请将可移动介质连接到您的没有网络访问限制的工作站。

如果您正在使用私有 registry,包括

registry.redhat.io,请将REG_CREDS环境变量设置为 registry 凭证的文件路径,以便在后续步骤中使用。例如,对于podmanCLI:$ REG_CREDS=${XDG_RUNTIME_DIR}/containers/auth.json

3.3.7.2. 提取和镜像目录内容

oc adm catalog mirror 命令提取索引镜像的内容,以生成镜像所需的清单。命令的默认行为会生成清单,然后会自动将索引镜像以及索引镜像本身中的所有镜像内容镜像(mirror)到您的镜像 registry。

另外,如果您的镜像 registry 位于完全断开连接的主机上,或者断开连接的或 airgapped 主机上,您可以首先将内容镜像到可移动介质,将介质移到断开连接的环境中,然后将内容从介质镜像到 registry。

3.3.7.2.1. 将目录内容镜像到同一网络上的 registry

如果您的镜像 registry 与您的没有网络访问限制的工作站位于同一个网络中,请在您的工作站上执行以下操作:

流程

如果您的镜像 registry 需要身份验证,请运行以下命令登录到 registry:

$ podman login <mirror_registry>

运行以下命令,将内容提取并镜像到镜像 registry:

$ oc adm catalog mirror \ <index_image> \ 1 <mirror_registry>:<port>[/<repository>] \ 2 [-a ${REG_CREDS}] \ 3 [--insecure] \ 4 [--index-filter-by-os='<platform>/<arch>'] \ 5 [--manifests-only] 6- 1

- 指定您要镜像的目录的索引镜像。例如,这可能是之前创建的已修剪索引镜像,也可以是默认目录的源索引镜像之一,如

registry.redhat.io/redhat/redhat-operator-index:v4.10。 - 2

- 指定要将 Operator 内容镜像到的目标 registry 的完全限定域名(FQDN)。镜像 registry

<repository>可以是 registry 上的任何现有存储库或命名空间,如先决条件中所述,如olm-mirror。如果在镜像过程中找到现有的存储库,存储库名称将添加到生成的镜像名称中。如果您不希望镜像名称包含存储库名称,请省略此行中的<repository>值,例如<mirror_registry>:<port>。 - 3

- 可选:如果需要,指定 registry 凭证文件的位置。

registry.redhat.io需要{REG_CREDS}。 - 4

- 可选:如果您不想为目标 registry 配置信任,请添加

--insecure标志。 - 5

- 可选:在有多个变体可用时,指定索引镜像的平台和架构。镜像被传递为

'<platform>/<arch>[/<variant>]'。这不适用于索引引用的镜像。有效值为linux/amd64、linux/ppc64le、linux/s390x和.* - 6

- 可选:只生成镜像所需的清单,但并不实际将镜像内容镜像到 registry。这个选项对检查哪些将被镜像(mirror)非常有用,如果您只需要一小部分软件包,可以对映射列表进行修改。然后,您可以使用带有

oc image mirror命令的mapping.txt文件来在以后的步骤中镜像修改的镜像列表。此标志仅用于从目录中对内容进行高级选择性镜像;opm index prune命令适用于大多数目录管理用例,如果之前用来修剪索引镜像。

输出示例

src image has index label for database path: /database/index.db using database path mapping: /database/index.db:/tmp/153048078 wrote database to /tmp/153048078 1 ... wrote mirroring manifests to manifests-redhat-operator-index-1614211642 2

注意Red Hat Quay 不支持嵌套存储库。因此,运行

oc adm catalog mirror命令会失败,并显示401未授权错误。作为临时解决方案,您可以在运行oc adm catalog mirror命令时使用--max-components=2选项来禁用嵌套存储库的创建。有关此临时解决方案的更多信息,请参阅 Unauthorized error thrown while using catalog mirror command with Quay registry。

其他资源

3.3.7.2.2. 将目录内容镜像到 airgapped registry

如果您的镜像 registry 位于完全断开连接的主机上,或 airgapped 主机上,请执行以下操作。

流程

在您的工作站中运行以下命令,且没有网络访问权限将内容镜像到本地文件中:

$ oc adm catalog mirror \ <index_image> \ 1 file:///local/index \ 2 -a ${REG_CREDS} \ 3 --insecure \ 4 --index-filter-by-os='<platform>/<arch>' 5- 1

- 指定您要镜像的目录的索引镜像。例如,这可能是之前创建的已修剪索引镜像,也可以是默认目录的源索引镜像之一,如

registry.redhat.io/redhat/redhat-operator-index:v4.10。 - 2

- 指定要镜像到当前目录中的本地文件的内容。

- 3

- 可选:如果需要,指定 registry 凭证文件的位置。

- 4

- 可选:如果您不想为目标 registry 配置信任,请添加

--insecure标志。 - 5

- 可选:在有多个变体可用时,指定索引镜像的平台和架构。镜像被指定为

'<platform>/<arch>[/<variant>]'。这不适用于索引引用的镜像。有效值为linux/amd64、linux/ppc64le、linux/s390x和.*

输出示例

... info: Mirroring completed in 5.93s (5.915MB/s) wrote mirroring manifests to manifests-my-index-1614985528 1 To upload local images to a registry, run: oc adm catalog mirror file://local/index/myrepo/my-index:v1 REGISTRY/REPOSITORY 2

此命令会在当前目录中创建

v2/目录中。-

将

v2/目录复制到可移动介质。 - 物理删除该介质并将其附加到断开连接的环境中可访问镜像 registry 的主机。

如果您的镜像 registry 需要身份验证,请在断开连接的环境中的主机上运行以下命令以登录到 registry:

$ podman login <mirror_registry>

从包含

v2/目录的父目录运行以下命令,将镜像从本地文件上传到镜像 registry:$ oc adm catalog mirror \ file://local/index/<repository>/<index_image>:<tag> \ 1 <mirror_registry>:<port>[/<repository>] \ 2 -a ${REG_CREDS} \ 3 --insecure \ 4 --index-filter-by-os='<platform>/<arch>' 5- 1

- 指定上一命令输出中的

file://路径。 - 2

- 指定要将 Operator 内容镜像到的目标 registry 的完全限定域名(FQDN)。镜像 registry

<repository>可以是 registry 上的任何现有存储库或命名空间,如先决条件中所述,如olm-mirror。如果在镜像过程中找到现有的存储库,存储库名称将添加到生成的镜像名称中。如果您不希望镜像名称包含存储库名称,请省略此行中的<repository>值,例如<mirror_registry>:<port>。 - 3

- 可选:如果需要,指定 registry 凭证文件的位置。

- 4

- 可选:如果您不想为目标 registry 配置信任,请添加

--insecure标志。 - 5

- 可选:在有多个变体可用时,指定索引镜像的平台和架构。镜像被指定为

'<platform>/<arch>[/<variant>]'。这不适用于索引引用的镜像。有效值为linux/amd64、linux/ppc64le、linux/s390x和.*

注意Red Hat Quay 不支持嵌套存储库。因此,运行

oc adm catalog mirror命令会失败,并显示401未授权错误。作为临时解决方案,您可以在运行oc adm catalog mirror命令时使用--max-components=2选项来禁用嵌套存储库的创建。有关此临时解决方案的更多信息,请参阅 Unauthorized error thrown while using catalog mirror command with Quay registry。再次运行

oc adm catalog mirror命令。使用新镜像的索引镜像作为源,以及上一步中使用的同一镜像 registry 目标:$ oc adm catalog mirror \ <mirror_registry>:<port>/<index_image> \ <mirror_registry>:<port>[/<repository>] \ --manifests-only \1 [-a ${REG_CREDS}] \ [--insecure]- 1

- 此步骤需要

--manifests-only标志,以便该命令不会再次复制所有镜像的内容。

重要这一步是必需的,因为上一步中生成的

imageContentSourcePolicy.yaml文件中的镜像映射必须从本地路径更新为有效的镜像位置。如果不这样做,会在稍后的步骤中创建ImageContentSourcePolicy对象时会导致错误。

在镜像目录后,您可以继续执行集群的其余部分。在集群安装成功完成后,您必须指定此流程中的 manifests 目录来创建 ImageContentSourcePolicy 和 CatalogSource 对象。需要这些对象才能从 OperatorHub 安装 Operator。

其他资源

3.3.7.3. 生成的清单

将 Operator 目录内容镜像到镜像 registry 后,会在当前目录中生成清单目录。

如果您将内容镜像到同一网络上的 registry,则目录名称采用以下模式:

manifests-<index_image_name>-<random_number>

如果您在上一节中将内容镜像到断开连接的主机上的 registry,则目录名称采用以下模式:

manifests-index/<repository>/<index_image_name>-<random_number>

清单目录名称在后续过程中被引用。

manifests 目录包含以下文件,其中的一些文件可能需要进一步修改:

catalogSource.yaml文件是CatalogSource对象的基本定义,它预先填充索引镜像标签及其他相关元数据。此文件可原样使用,或进行相应修改来在集群中添加目录源。重要如果将内容镜像到本地文件,您必须修改 catalogSource

.yaml文件,从metadata.name字段中删除任何反斜杠(/)字符。否则,当您试图创建对象时,会失败并显示 "invalid resource name” 错误。用来定义

ImageContentSourcePolicy对象的imageContentSourcePolicy.yaml,它可以将节点配置为在 Operator 清单中存储的镜像(image)引用和镜像 (mirror) 的 registry 间进行转换。注意如果您的集群使用

ImageContentSourcePolicy对象来配置存储库镜像,则只能将全局 pull secret 用于镜像 registry。您不能在项目中添加 pull secret。mapping.txt文件,在其中包含所有源镜像,并将它们映射到目标 registry。此文件与oc image mirror命令兼容,可用于进一步自定义镜像(mirror)配置。重要如果您在镜像过程中使用

--manifests-only标志,并希望进一步调整要镜像的软件包子集,请参阅 OpenShift Container Platform 4.7 文档中的镜像软件包清单格式目录镜像流程中有关修改mapping.txt文件并使用oc image mirror命令的步骤。

3.3.7.4. 安装后的要求

在镜像目录后,您可以继续执行集群的其余部分。在集群安装成功完成后,您必须指定此流程中的 manifests 目录来创建 ImageContentSourcePolicy 和 CatalogSource 对象。这些对象需要填充和启用从 OperatorHub 安装 Operator。

3.3.8. 后续步骤

- 在您在受限网络中置备的基础架构上安装集群,如 VMware vSphere、裸机或 Amazon Web Services。

3.3.9. 其他资源

- 有关使用 must-gather 的更多信息,请参阅收集有关特定功能的数据。

3.4. 使用 oc-mirror 插件为断开连接的安装镜像镜像

您可以确保集群只使用满足您机构对外部内容控制的容器镜像。在受限网络中置备的基础架构上安装集群前,您必须将所需的容器镜像镜像(mirror)到那个环境中。要镜像容器镜像,您必须有一个 registry 才能进行镜像(mirror)。

您可以使用 oc-mirror OpenShift CLI (oc)插件在完全或部分断开连接的环境中将镜像镜像到镜像 registry。

使用 oc-mirror 插件为断开连接的环境 mirror 镜像只是一个技术预览功能。技术预览功能不受红帽产品服务等级协议(SLA)支持,且功能可能并不完整。红帽不推荐在生产环境中使用它们。这些技术预览功能可以使用户提早试用新的功能,并有机会在开发阶段提供反馈意见。

有关红帽技术预览功能支持范围的更多信息,请参阅技术预览功能支持范围。

下列步骤概述了如何使用 oc-mirror 插件将镜像镜像到镜像 registry 的高级别工作流:

- 创建镜像设置配置文件。

- 将镜像设置为镜像 registry。

- 配置集群以使用 oc-mirror 插件生成的资源。

- 根据需要重复这些步骤以更新您的镜像 registry。

3.4.1. 关于 oc-mirror 插件

您可以使用 oc-mirror OpenShift CLI(oc)插件,使用单个工具将所有所需的 OpenShift Container Platform 内容和其他镜像(mirror)镜像到您的镜像 registry。它提供以下功能:

- 提供镜像 OpenShift Container Platform 发行版本、Operator、helm chart 和其他镜像的集中方法。

- 维护 OpenShift Container Platform 和 Operator 的更新路径。

- 使用声明的镜像设置配置文件来仅包含集群所需的 OpenShift Container Platform 发行版本、Operator 和镜像。

- 执行增量镜像,从而减少将来镜像集的大小。

使用 oc-mirror 插件时,您可以在镜像设置配置文件中指定要镜像的内容。在这个 YAML 文件中,您可以将配置微调为仅包含集群需要的 OpenShift Container Platform 发行版本和 Operator。这可减少您下载和传输所需的数据量。oc-mirror 插件也可以镜像任意 helm chart 和附加容器镜像,以帮助用户将其工作负载无缝同步到镜像 registry 中。

第一次运行 oc-mirror 插件时,它会使用所需内容填充您的镜像 registry,以执行断开连接的集群安装。要让断开连接的集群继续接受更新,您必须更新镜像 registry。要更新您的镜像 registry,请使用与第一次运行相同的配置运行 oc-mirror 插件。oc-mirror 插件引用存储后端的元数据,并只下载上次运行该工具后所发布的元数据。这为 OpenShift Container Platform 和 Operator 提供了更新路径,并根据需要执行依赖项解析。

当使用 oc-mirror CLI 插件填充镜像 registry 时,必须使用 oc-mirror 工具对镜像 registry 进行进一步的更新。

3.4.2. 关于镜像 registry

您可以将 OpenShift Container Platform 安装和后续的产品更新镜像(mirror)到支持 Docker v2-2 (如 Red Hat Quay)的容器镜像(如 Red Hat Quay)的容器镜像。如果您无法访问大型容器 registry,可以使用 Red Hat OpenShift 的镜像 registry,这是 OpenShift 中包含的小型容器 registry。

无论您所选 registry 是什么,都会将互联网上红帽托管站点的内容镜像到隔离的镜像 registry 相同。镜像内容后,您要将每个集群配置为从镜像 registry 中检索此内容。

OpenShift 镜像 registry 不能用作目标 registry,因为它不支持没有标签的推送,在镜像过程中需要这个推送。

如果选择的容器 registry 不是 mirror registry for Red Hat OpenShift,则需要集群中置备的每台机器都可以访问它。如果 registry 无法访问,安装、更新或常规操作(如工作负载重新定位)可能会失败。因此,您必须以高度可用的方式运行镜像 registry,镜像 registry 至少必须与 OpenShift Container Platform 集群的生产环境可用性相匹配。

使用 OpenShift Container Platform 镜像填充镜像 registry 时,可以遵循以下两种情况。如果您的主机可以同时访问互联网和您的镜像 registry,而不能访问您的集群节点,您可以直接从该机器中镜像该内容。这个过程被称为 连接的镜像(mirror)。如果没有这样的主机,则必须将该镜像文件镜像到文件系统中,然后将该主机或者可移动介质放入受限环境中。这个过程被称为 断开连接的镜像。

对于已镜像的 registry,若要查看拉取镜像的来源,您必须查看 Trying 以访问 CRI-O 日志中的日志条目。查看镜像拉取源的其他方法(如在节点上使用 crictl images 命令)显示非镜像镜像名称,即使镜像是从镜像位置拉取的。

红帽没有针对 OpenShift Container Platform 测试第三方 registry。

其他资源

- 有关查看 CRI-O 日志以查看镜像源的详情,请参阅查看镜像拉取源。

3.4.3. 先决条件

您必须在托管 OpenShift Container Platform 集群的位置(如 Red Hat Quay)中有一个支持 Docker v2-2 的容器镜像 registry。

注意如果使用 Red Hat Quay,则必须在 oc-mirror 插件中使用 3.6 或更高版本的版本。如果您有 Red Hat Quay 权利,请参阅有关部署 Red Hat Quay 以了解概念验证的文档,或使用 Quay Operator。如果您需要额外的帮助来选择并安装 registry,请联络您的销售代表或红帽支持。

如果您还没有容器镜像 registry,OpenShift Container Platform 可以为订阅者提供一个 mirror registry for Red Hat OpenShift。Red Hat OpenShift 的镜像 registry 包含在您的订阅中,它是一个小型容器 registry,可用于在断开连接的安装中镜像 OpenShift Container Platform 所需的容器镜像。

3.4.4. 准备您的镜像主机

在使用 oc-mirror 插件镜像(mirror)前,您必须安装插件并创建容器镜像 registry 凭据文件,以允许从红帽镜像到您的镜像。

3.4.4.1. 安装 oc-mirror OpenShift CLI 插件

要使用 oc-mirror OpenShift CLI 插件来镜像 registry 镜像,您必须安装插件。如果您在一个完全断开连接的环境中镜像镜像集,请确保在具有互联网访问的主机上的 oc-mirror 插件以及可访问镜像 registry 的断开连接的环境中安装 oc-mirror 插件。

先决条件

-

已安装 OpenShift CLI(

oc)。

流程

下载 oc-mirror CLI 插件。

- 导航到 OpenShift Cluster Manager 的 Downloads 页面。

- 在 OpenShift disconnected 安装工具部分下,点 Download for OpenShift Client(oc)mirror 插件 并保存该文件。

解压归档:

$ tar xvzf oc-mirror.tar.gz

如有必要,将插件文件更新为可执行。

$ chmod +x oc-mirror

注意不要重命名

oc-mirror文件。通过将文件放在

PATH中,例如/usr/local/bin,安装 oc-mirror CLI 插件:$ sudo mv oc-mirror /usr/local/bin/.

验证

运行

oc mirror help来验证插件是否已成功安装:$ oc mirror help

其他资源

3.4.4.2. 配置允许对容器镜像进行镜像的凭证

创建容器镜像 registry 凭证文件,允许将红帽的镜像镜像到您的镜像环境中。

安装集群时不要使用此镜像 registry 凭据文件作为 pull secret。如果在安装集群时提供此文件,集群中的所有机器都将具有镜像 registry 的写入权限。

此过程需要您可以对镜像 registry 上的容器镜像 registry 进行写操作,并将凭证添加到 registry pull secret。

先决条件

- 您已将镜像 registry 配置为在断开连接的环境中使用。

- 您在镜像 registry 中标识了镜像仓库的位置,以将容器镜像镜像(mirror)到这个位置。

- 您置备了一个镜像 registry 帐户,允许将镜像上传到该镜像仓库。

流程

在安装主机上完成以下步骤:

-

下载您的

registry.redhat.iopull secret(从Red Hat OpenShift Cluster Manager)。 以 JSON 格式创建您的 pull secret 副本:

$ cat ./pull-secret | jq . > <path>/<pull_secret_file_in_json> 1- 1

- 指定到存储 pull secret 的文件夹的路径,以及您创建的 JSON 文件的名称。

将文件保存为

~/.docker/config.json或$XDG_RUNTIME_DIR/containers/auth.json。该文件类似于以下示例:

{ "auths": { "cloud.openshift.com": { "auth": "b3BlbnNo...", "email": "you@example.com" }, "quay.io": { "auth": "b3BlbnNo...", "email": "you@example.com" }, "registry.connect.redhat.com": { "auth": "NTE3Njg5Nj...", "email": "you@example.com" }, "registry.redhat.io": { "auth": "NTE3Njg5Nj...", "email": "you@example.com" } } }为您的镜像 registry 生成 base64 编码的用户名和密码或令牌:

$ echo -n '<user_name>:<password>' | base64 -w0 1 BGVtbYk3ZHAtqXs=- 1

- 通过

<user_name>和<password>指定 registry 的用户名和密码。

编辑 JSON 文件并添加描述 registry 的部分:

"auths": { "<mirror_registry>": { 1 "auth": "<credentials>", 2 "email": "you@example.com" } },该文件类似于以下示例:

{ "auths": { "registry.example.com": { "auth": "BGVtbYk3ZHAtqXs=", "email": "you@example.com" }, "cloud.openshift.com": { "auth": "b3BlbnNo...", "email": "you@example.com" }, "quay.io": { "auth": "b3BlbnNo...", "email": "you@example.com" }, "registry.connect.redhat.com": { "auth": "NTE3Njg5Nj...", "email": "you@example.com" }, "registry.redhat.io": { "auth": "NTE3Njg5Nj...", "email": "you@example.com" } } }

3.4.5. 创建镜像设置配置

在使用 oc-mirror 插件镜像集之前,必须先创建镜像设置配置文件。此镜像设置配置文件定义哪些 OpenShift Container Platform 发行版本、Operator 和其他镜像要镜像,以及 oc-mirror 插件的其他配置设置。

您必须在镜像设置配置文件中指定存储后端。此存储后端可以是本地目录或支持 Docker v2-2 的 registry。oc-mirror 插件在创建镜像的过程中将元数据存储在这个存储后端中。

不要删除或修改 oc-mirror 插件生成的元数据。每次针对同一镜像 registry 运行 oc-mirror 插件时,都必须使用相同的存储后端。

流程

创建指定所需配置详情的

ImageSetConfiguration资源:ImageSetConfiguration文件示例apiVersion: mirror.openshift.io/v1alpha1 kind: ImageSetConfiguration archiveSize: 4 1 mirror: ocp: channels: - name: stable-4.9 2 operators: - catalog: registry.redhat.io/redhat/redhat-operator-index:v4.9 3 storageConfig: 4 registry: imageURL: example.com/example/oc-mirror 5

本例从

registry.redhat.io/redhat/redhat-operator-index:v4.9operator 目录的stable-4.9频道拉取镜像,并将镜像设置元数据保存到example.com/example/oc-mirrorregistry。-

将文件保存为

imageset-config.yaml。在镜像内容时,oc mirror命令需要此文件。

3.4.6. 将镜像集镜像(mirror)到镜像 registry

您可以使用 oc-mirror CLI 插件在 部分断开连接的环境中或完全断开连接的环境中将镜像镜像到镜像 registry。

这些步骤假定您已设置了镜像 registry。

3.4.6.1. 在部分断开连接的环境中镜像设置的镜像

在部分断开连接的环境中,您可以直接镜像到目标镜像 registry 的镜像。

3.4.6.1.1. 镜像(mirror)到镜像(mirror)的镜像

您可以使用 oc-mirror 插件将镜像直接设置为在镜像设置过程中可访问的目标镜像 registry。

根据镜像设置配置文件中指定的配置,使用 oc-mirror 将镜像镜像(mirror)镜像,在镜像到目标镜像 registry 之前,可能会将几百 GB 的数据下载到磁盘。

您填充镜像 registry 时初始镜像集下载通常是最大镜像。因为您只下载自上次运行命令以来更改的镜像,所以再次运行 oc-mirror 插件时,所生成的镜像集通常比较小。

您必须在镜像设置配置文件中指定存储后端。这个存储后端可以是本地目录或 Docker v2 registry。oc-mirror 插件在创建镜像的过程中将元数据存储在这个存储后端中。

不要删除或修改 oc-mirror 插件生成的元数据。每次针对同一镜像 registry 运行 oc-mirror 插件时,都必须使用相同的存储后端。

先决条件

- 您可以访问互联网来获取所需的容器镜像。

-

已安装 OpenShift CLI(

oc)。 -

已安装

oc-mirrorCLI 插件。 - 您已创建了镜像设置配置文件。

流程

运行

oc mirror命令将指定镜像集配置中的镜像镜像到指定的 registry:$ oc mirror --config=./imageset-config.yaml \ 1 docker://registry.example:5000 2

验证

-

进入生成的

oc-mirror-workspace/目录。 -

导航到结果目录,例如,

results-1639608409/。 -

验证

ImageContentSourcePolicy和CatalogSource资源是否存在 YAML 文件。

后续步骤

- 配置集群以使用 oc-mirror 生成的资源。

3.4.6.2. 镜像在完全断开连接的环境中设置的镜像

要镜像在完全断开连接的环境中设置的镜像,您必须首先将镜像集镜像到磁盘, 然后将磁盘上的镜像集文件镜像到一个镜像。

3.4.6.2.1. 从镜像镜像到磁盘

您可以使用 oc-mirror 插件生成镜像集,并将内容保存到磁盘。然后,生成的镜像集可以转移到断开连接的环境中,并镜像到目标 registry。

根据镜像设置配置文件中指定的配置,使用 oc-mirror 的镜像可能会将几百 GB 数据下载到磁盘。

您填充镜像 registry 时初始镜像集下载通常是最大镜像。因为您只下载自上次运行命令以来更改的镜像,所以再次运行 oc-mirror 插件时,所生成的镜像集通常比较小。

您必须在镜像设置配置文件中指定存储后端。这个存储后端可以是本地目录或 docker v2 registry。oc-mirror 插件在创建镜像的过程中将元数据存储在这个存储后端中。

不要删除或修改 oc-mirror 插件生成的元数据。每次针对同一镜像 registry 运行 oc-mirror 插件时,都必须使用相同的存储后端。

先决条件

- 您可以访问互联网来获取所需的容器镜像。

-

已安装 OpenShift CLI(

oc)。 -

已安装

oc-mirrorCLI 插件。 - 您已创建了镜像设置配置文件。

流程

运行

oc mirror命令将指定镜像集配置镜像到磁盘:$ oc mirror --config=./imageset-config.yaml \ 1 file://<path_to_output_directory> 2

验证

进入您的输出目录:

$ cd <path_to_output_directory>

验证是否创建了镜像设置

.tar文件:$ ls

输出示例

mirror_seq1_000000.tar

后续步骤

- 将镜像集 .tar 文件移动到断开连接的环境中。

3.4.6.2.2. 从磁盘镜像到镜像

您可以使用 oc-mirror 插件将生成的镜像集的内容镜像到目标镜像 registry。

先决条件

-

您已在断开连接的环境中安装了 OpenShift CLI(

oc)。 -

您已在断开连接的环境中安装了

oc-mirrorCLI 插件。 -

已使用

oc mirror命令生成镜像集文件。 - 您已将镜像集文件传送到断开连接的环境中。

流程

运行

oc mirror命令,以处理磁盘上镜像集文件,并将内容镜像到目标镜像 registry:$ oc mirror --from=./mirror_seq1_000000.tar \ 1 docker://registry.example:5000 2

此命令使用镜像集更新镜像 registry,并生成

ImageContentSourcePolicy和CatalogSource资源。

验证

-

进入生成的

oc-mirror-workspace/目录。 -

导航到结果目录,例如,

results-1639608409/。 -

验证

ImageContentSourcePolicy和CatalogSource资源是否存在 YAML 文件。

后续步骤

- 配置集群以使用 oc-mirror 生成的资源。

3.4.7. 配置集群以使用 oc-mirror 生成的资源

将镜像设置为镜像 registry 后,您必须将生成的 ImageContentSourcePolicy、CatalogSource 和发行版本镜像签名资源应用到集群。

ImageContentSourcePolicy 资源将镜像 registry 与源 registry 关联,并将在线 registry 中的镜像拉取请求重定向到镜像 registry。Operator Lifecycle Manager(OLM)使用 CatalogSource 资源检索有关镜像 registry 中可用 Operator 的信息。发行镜像签名用于验证镜像的发行镜像。

先决条件

- 您已将镜像设置为断开连接的环境中的 registry 镜像。

-

您可以使用具有

cluster-admin角色的用户访问集群。

流程

-

以具有

cluster-admin角色的用户身份登录 OpenShift CLI。 运行以下命令,将结果目录中的 YAML 文件应用到集群:

$ oc apply -f ./oc-mirror-workspace/results-1639608409/

运行以下命令,将发行版本镜像签名应用到集群:

$ oc apply -f ./oc-mirror-workspace/results-1639608409/release-signatures/

验证

运行以下命令验证

ImageContentSourcePolicy资源是否已成功安装:$ oc get imagecontentsourcepolicy --all-namespaces

运行以下命令验证

CatalogSource资源是否已成功安装:$ oc get catalogsource --all-namespaces

3.4.8. 更新您的镜像 registry

将完整镜像集发布到镜像 registry 后,您可以使用 oc-mirror 插件使用更新的镜像更新镜像 registry。

当您再次运行 oc-mirror 插件时,它会生成一个镜像集,该集合仅包含与之前执行后的全新和更新镜像。

您必须使用与 oc-mirror 的初始执行相同镜像 registry 的存储后端。不要删除或修改 oc-mirror 插件生成的元数据。

因为它只拉取自以前的镜像集的差异,所以所生成的镜像集通常比初始镜像集更小且更快。

生成的镜像集是连续的,且必须同步到目标镜像 registry。

先决条件

- 您已使用 oc-mirror 插件将初始镜像设置为您的镜像 registry。

- 您可以访问用于进行 oc-mirror 插件的初始执行的存储后端。

流程

按照以下步骤创建初始镜像集并将其镜像到镜像 registry。具体步骤,请参阅在部分断开连接的环境中镜像镜像集,或在完全断开连接的环境中镜像镜像集。

重要- 您必须提供相同的存储后端,以便只创建并镜像不同的镜像集。

- 如果您在初始镜像集创建过程中为镜像 registry 指定顶层命名空间,则每次针对同一镜像 registry 运行 oc-mirror 插件时都必须使用此命名空间。

- 配置集群以使用 oc-mirror 生成的资源。

3.4.9. 镜像设置配置参数

oc-mirror 插件需要一个镜像设置配置文件,该文件定义哪些镜像要镜像(mirror)。下表列出了 ImageSetConfiguration 资源的可用参数。

表 3.1. ImageSetConfiguration 参数

| 参数 | 描述 | 值 |

|---|---|---|

|

|

|

字符串.例如: |

|

| 镜像集中的每个存档文件的最大大小(以 GiB 为单位)。 |

整数.例如: |

|

| 镜像集的配置。 | 对象 |

|

| 镜像集的额外镜像配置。 | 对象数组。例如: additionalImages: - name: registry.redhat.io/ubi8/ubi:latest |

|

| 要镜像的镜像标签。 |

字符串.例如: |

|

| 镜像集的 helm 配置。请注意,oc-mirror 插件只支持 helm chart,在呈现时不需要用户输入。 | 对象 |

|

| 要镜像的本地 helm chart。 | 对象数组。例如: local:

- name: podinfo

path: /test/podinfo-5.0.0.tar.gz

|

|

| 要镜像的本地 helm chart 的名称。 |

字符串.例如: |

|

| 到镜像的本地 helm chart 的路径。 |

字符串.例如: |

|

| 从其中镜像的的远程 helm 软件仓库。 | 对象数组。例如: repos:

- name: podinfo

url: https://example.github.io/podinfo

charts:

- name: podinfo

version: 5.0.0

|

|

| 从其中镜像(mirror)的 helm 存储库的名称。 |

字符串.例如: |

|

| 从其中镜像(mirror)的 helm 存储库的 URL。 |

字符串.例如: |

|

| 要镜像的远程 helm chart。 | 对象数组。 |

|

| 要镜像的 helm chart 的名称。 |

字符串.例如: |

|

| 要镜像命名 helm chart 的版本。 |

字符串.例如: |

|

| 镜像集的平台配置。 | 对象 |

|

| 镜像集的平台频道配置。 | 对象数组。例如: channels:

- name: stable-4.7

- name: stable-4.6

versions:

- '4.6.36'

|

|

| 发行频道的名称。 |

字符串.例如: |

|

| 命名频道的发行版本列表。 |

字符串.例如: |

|

| 镜像集的 Operator 配置。 | 对象数组。例如: operators:

- catalog: registry.redhat.io/redhat/redhat-operator-index:v4.9

headsOnly: false

packages:

- name: elasticsearch-operator

startingVersion: '2.4.0'

|

|

| 包括在镜像集中的 Operator 目录。 |

字符串.例如: |

|

|

在下载频道 HEAD 和完整频道间切换。无法与 | 布尔值 |

|

| Operator 软件包配置。 | 对象数组。例如: operators:

- catalog: registry.redhat.io/redhat/redhat-operator-index:v4.8

headsOnly: false

packages:

- name: elasticsearch-operator

startingVersion: '5.2.3-31'

|

|

| 镜像集中要包含的 Operator 软件包名称 |

字符串.例如: |

|

|

待镜像 Operator 软件包的起始版本。Operator 的所有版本都会在 |

字符串.例如: |

|

| Operator 软件包频道配置。 | 对象 |

|

| Operator 频道名称(软件包中唯一)要包括在镜像集中。 |

字符串.例如: |

|

|

要镜像的 Operator 频道的起始版本。Operator 的所有版本都会在 |

字符串.例如: |

|

| 镜像集的后端配置。 | 对象 |

|

| 镜像集的本地后端配置。 | 对象 |

|

| 包含镜像设置元数据的目录路径。 |

字符串.例如: |

|

| 镜像集的 registry 后端配置。 | 对象 |

|

| 后端 registry URI。可以选择在 URI 中包含命名空间引用。 |

字符串.例如: |

|

| (可选)跳过引用的后端 registry 的 TLS 验证。 |

布尔值.默认值为 |

3.4.10. 镜像设置配置示例

以下 ImageSetConfiguration 文件示例演示了各种镜像用例的配置。

用例:包含任意镜像和 helm chart

以下 ImageSetConfiguration 文件使用 registry 存储后端,并包含 helm chart 和额外的 Red Hat Universal Base Image(UBI)。

ImageSetConfiguration 文件示例

apiVersion: mirror.openshift.io/v1alpha1

kind: ImageSetConfiguration

archiveSize: 4

storageConfig:

registry:

imageURL: example.com/example/oc-mirror

skipTLS: false

mirror:

ocp:

channels:

- name: stable-4.10

operators:

- catalog: registry.redhat.io/redhat/redhat-operator-index:v4.10

helm:

repos:

- name: redhat-helm-charts

url: https://raw.githubusercontent.com/redhat-developer/redhat-helm-charts/master

charts:

- name: ibm-mongodb-enterprise-helm

version: 0.2.0

additionalImages:

- name: registry.redhat.io/ubi8/ubi:latest

使用案例:包含特定的 Operator 版本

以下 ImageSetConfiguration 文件使用本地存储后端,仅包含从 3.67.0 及之后的版本开始的 Red Hat Advanced Cluster Security for Kubernetes Operator。

ImageSetConfiguration 文件示例

apiVersion: mirror.openshift.io/v1alpha1

kind: ImageSetConfiguration

storageConfig:

local:

path: /home/user/metadata

mirror:

operators:

- catalog: registry.redhat.io/redhat/redhat-operator-index:v4.10

headsOnly: false

packages:

- name: rhacs-operator

channels:

- name: latest

startingVersion: 3.67.0

3.4.11. oc-mirror 的命令参考

下表描述了 oc mirror 子命令和标志:

表 3.2. oc mirror 子命令

| 子命令 | 描述 |

|---|---|

|

| 为指定的 shell 生成自动完成脚本。 |

|

| 输出镜像集合的内容。 |

|

| 显示有关任何子命令的帮助。 |

|

| 列出可用平台和 Operator 内容及其版本。 |

|

| 输出 oc-mirror 版本。 |

表 3.3. oc mirror 标记

| 标记 | 描述 |

|---|---|

|

| 指定镜像设置配置文件的路径。 |

|

| 如果发生任何非镜像拉取相关的错误,请继续并尝试进行镜像(mirror)。 |

|

| 禁用目标 registry 的 TLS 验证。 |

|

| 使用 HTTP 用于目标 registry。 |

|

| 仅输出操作情况,不实际 mirror 镜像。 |

|

| 指定由执行 oc-mirror 生成的镜像设置归档的路径,以加载到目标 registry 中。 |

|

| 显示帮助。 |

|

|

指定日志级别详细程度的数量。有效值为 |

|

|

为 |

|

| 跳过删除工件目录。 |

|

| 不要将镜像标签替换为 Operator 目录中的摘要。 |

|

| 如果没有找到镜像,则跳过它而不是报告错误并中止执行。不适用于在镜像设置配置中明确指定的自定义镜像。 |

|

| 跳过摘要验证。 |

|

| 为源 registry 禁用 TLS 验证。 |

|

| 将普通 HTTP 用于源 registry。 |

第 4 章 在 Alibaba 上安装

4.1. 准备在 Alibaba Cloud 上安装

OpenShift Container Platform 上的 Alibaba Cloud 只是一个技术预览功能。技术预览功能不受红帽产品服务等级协议(SLA)支持,且功能可能并不完整。红帽不推荐在生产环境中使用它们。这些技术预览功能可以使用户提早试用新的功能,并有机会在开发阶段提供反馈意见。

有关红帽技术预览功能支持范围的更多信息,请参阅技术预览功能支持范围。

4.1.1. 先决条件

- 您可以参阅有关 OpenShift Container Platform 安装和更新 流程的详细信息。

- 您可以阅读选择集群安装方法并为用户准备它的文档。

4.1.2. 在 Alibaba Cloud 上安装 OpenShift Container Platform 的要求

在 Alibaba Cloud 上安装 OpenShift Container Platform 前,您必须配置并注册您的域,为安装创建 Resource Access Management(RAM)用户,并查看支持的 Alibaba Cloud 数据中心区域和区。

4.1.3. 注册和配置 Alibaba Cloud 域

要安装 OpenShift Container Platform,您使用的 Alibaba Cloud 帐户必须在帐户中有一个专用的公共托管区。此区域必须对域具有权威。此服务为集群外部连接提供集群 DNS 解析和名称查询。

流程

标识您的域或子域,以及注册商(registrar)。您可以转移现有的域和注册商,或通过 Alibaba Cloud 或其他来源获取新的域和注册商。

注意如果您通过 Alibaba Cloud 购买了一个新域,则需要时间来传播相关的 DNS 更改。有关通过 Alibaba Cloud 购买域的更多信息,请参阅 Alibaba Cloud 域。

- 如果您使用现有的域和注册商,请将其 DNS 迁移到 Alibaba Cloud。请参阅 Alibaba Cloud 文档中的 域名传输 部分。

为您的域配置 DNS。这包括:

- 注册通用域名。

- 为您的域名完成实际的验证。

- 为互联网内容提供程序(ICP)填充应用.

使用合适的根域(如

openshiftcorp.com)或子域(如clusters.openshiftcorp.com)。

- 如果您使用子域,请按照您公司的流程将其委托记录添加到父域中。

4.1.4. 支持的 Alibaba 区域

您可以将 OpenShift Container Platform 集群部署到 Alibaba Regions and zones 文档中列出的区域。

4.1.5. 后续步骤

4.2. 创建所需的 Alibaba 云资源

在安装 OpenShift Container Platform 前,您必须使用 Alibaba Cloud 控制台创建一个资源访问管理(RAM)用户,该用户有足够的权限将 OpenShift Container Platform 安装到 Alibaba Cloud 中。此用户还必须具有创建新 RAM 用户的权限。您还可以配置和使用 ccoctl 工具为 OpenShift Container Platform 组件创建新凭证,及其所需的权限。

OpenShift Container Platform 上的 Alibaba Cloud 只是一个技术预览功能。技术预览功能不受红帽产品服务等级协议(SLA)支持,且功能可能并不完整。红帽不推荐在生产环境中使用它们。这些技术预览功能可以使用户提早试用新的功能,并有机会在开发阶段提供反馈意见。

有关红帽技术预览功能支持范围的更多信息,请参阅技术预览功能支持范围。

4.2.1. 创建所需的 RAM 用户

您必须有一个 Alibaba Cloud Resource Access Management(RAM)用户才能进行安装具有足够权限。您可以使用 Alibaba Cloud Resource Access Management 控制台来创建新用户或修改现有用户。之后,您可以根据用户的权限在 OpenShift Container Platform 中创建凭证。

当您配置 RAM 用户时,请确定考虑以下要求:

用户必须具有 Alibaba Cloud AccessKey ID 和 AccessKey secret 对。

-

对于新用户,您可以在创建用户时为 Access Mode 选择

Open API Access。这个模式会生成所需的 AccessKey 对。 对于现有用户,您可以添加 AccessKey 对,或者您可以获取该用户的 AccessKey 对。

注意创建后,AccessKey secret 仅显示一次。您必须立即保存 AccessKey 对,因为 API 调用需要 accessKey 对。

-

对于新用户,您可以在创建用户时为 Access Mode 选择

将 AccessKey ID 和 secret 添加到本地计算机上的

~/.alibabacloud/credentials文件中。在登录到控制台时,Alibaba Cloud 会自动创建此文件。Cloud Credential Operator(CCO)实用程序 ccoutil 在处理凭证请求对象时使用这些凭证。例如:

[default] # Default client type = access_key # Certification type: access_key access_key_id = LTAI5t8cefXKmt # Key 1 access_key_secret = wYx56mszAN4Uunfh # Secret- 1

- 在这里添加您的 AccessKeyID 和 AccessKeySecret。

RAM 用户必须具有

AdministratorAccess策略,以确保帐户有充足的权限来创建 OpenShift Container Platform 集群。此策略授予管理所有 Alibaba Cloud 资源的权限。将

AdministratorAccess策略附加到 RAM 用户时,您可以授予用户对所有 Alibaba Cloud 服务和资源的完整访问权限。如果您不想创建具有完全访问权限的用户,请创建自定义策略,使其包含可添加到 RAM 用户以进行安装的以下操作。这些操作足以安装 OpenShift Container Platform。提示您可以将以下 JSON 代码复制并粘贴到 Alibaba Cloud 控制台中,以创建自定义策略。有关创建自定义策略的详情,请参考 Alibaba Cloud 文档中的创建自定义策略。

例 4.1. 自定义策略 JSON 文件示例

{ "Version": "1", "Statement": [ { "Action": [ "tag:ListTagResources", "tag:UntagResources" ], "Resource": "*", "Effect": "Allow" }, { "Action": [ "vpc:DescribeVpcs", "vpc:DeleteVpc", "vpc:DescribeVSwitches", "vpc:DeleteVSwitch", "vpc:DescribeEipAddresses", "vpc:DescribeNatGateways", "vpc:ReleaseEipAddress", "vpc:DeleteNatGateway", "vpc:DescribeSnatTableEntries", "vpc:CreateSnatEntry", "vpc:AssociateEipAddress", "vpc:ListTagResources", "vpc:TagResources", "vpc:DescribeVSwitchAttributes", "vpc:CreateVSwitch", "vpc:CreateNatGateway", "vpc:DescribeRouteTableList", "vpc:CreateVpc", "vpc:AllocateEipAddress", "vpc:ListEnhanhcedNatGatewayAvailableZones" ], "Resource": "*", "Effect": "Allow" }, { "Action": [ "ecs:ModifyInstanceAttribute", "ecs:DescribeSecurityGroups", "ecs:DeleteSecurityGroup", "ecs:DescribeSecurityGroupReferences", "ecs:DescribeSecurityGroupAttribute", "ecs:RevokeSecurityGroup", "ecs:DescribeInstances", "ecs:DeleteInstances", "ecs:DescribeNetworkInterfaces", "ecs:DescribeInstanceRamRole", "ecs:DescribeUserData", "ecs:DescribeDisks", "ecs:ListTagResources", "ecs:AuthorizeSecurityGroup", "ecs:RunInstances", "ecs:TagResources", "ecs:ModifySecurityGroupPolicy", "ecs:CreateSecurityGroup", "ecs:DescribeAvailableResource", "ecs:DescribeRegions", "ecs:AttachInstanceRamRole" ], "Resource": "*", "Effect": "Allow" }, { "Action": [ "pvtz:DescribeRegions", "pvtz:DescribeZones", "pvtz:DeleteZone", "pvtz:DeleteZoneRecord", "pvtz:BindZoneVpc", "pvtz:DescribeZoneRecords", "pvtz:AddZoneRecord", "pvtz:SetZoneRecordStatus", "pvtz:DescribeZoneInfo", "pvtz:DescribeSyncEcsHostTask", "pvtz:AddZone" ], "Resource": "*", "Effect": "Allow" }, { "Action": [ "slb:DescribeLoadBalancers", "slb:SetLoadBalancerDeleteProtection", "slb:DeleteLoadBalancer", "slb:SetLoadBalancerModificationProtection", "slb:DescribeLoadBalancerAttribute", "slb:AddBackendServers", "slb:DescribeLoadBalancerTCPListenerAttribute", "slb:SetLoadBalancerTCPListenerAttribute", "slb:StartLoadBalancerListener", "slb:CreateLoadBalancerTCPListener", "slb:ListTagResources", "slb:TagResources", "slb:CreateLoadBalancer" ], "Resource": "*", "Effect": "Allow" }, { "Action": [ "ram:ListResourceGroups", "ram:DeleteResourceGroup", "ram:ListPolicyAttachments", "ram:DetachPolicy", "ram:GetResourceGroup", "ram:CreateResourceGroup", "ram:DeleteRole", "ram:GetPolicy", "ram:DeletePolicy", "ram:ListPoliciesForRole", "ram:CreateRole", "ram:AttachPolicyToRole", "ram:GetRole", "ram:CreatePolicy", "ram:CreateUser", "ram:DetachPolicyFromRole", "ram:CreatePolicyVersion", "ram:DetachPolicyFromUser", "ram:ListPoliciesForUser", "ram:AttachPolicyToUser", "ram:CreateUser", "ram:GetUser", "ram:DeleteUser", "ram:CreateAccessKey", "ram:ListAccessKeys", "ram:DeleteAccessKey", "ram:ListUsers", "ram:ListPolicyVersions" ], "Resource": "*", "Effect": "Allow" }, { "Action": [ "oss:DeleteBucket", "oss:DeleteBucketTagging", "oss:GetBucketTagging", "oss:GetBucketCors", "oss:GetBucketPolicy", "oss:GetBucketLifecycle", "oss:GetBucketReferer", "oss:GetBucketTransferAcceleration", "oss:GetBucketLog", "oss:GetBucketWebSite", "oss:GetBucketInfo", "oss:PutBucketTagging", "oss:PutBucket", "oss:OpenOssService", "oss:ListBuckets", "oss:GetService", "oss:PutBucketACL", "oss:GetBucketLogging", "oss:ListObjects", "oss:GetObject", "oss:PutObject", "oss:DeleteObject" ], "Resource": "*", "Effect": "Allow" }, { "Action": [ "alidns:DescribeDomainRecords", "alidns:DeleteDomainRecord", "alidns:DescribeDomains", "alidns:DescribeDomainRecordInfo", "alidns:AddDomainRecord", "alidns:SetDomainRecordStatus" ], "Resource": "*", "Effect": "Allow" }, { "Action": "bssapi:CreateInstance", "Resource": "*", "Effect": "Allow" }, { "Action": "ram:PassRole", "Resource": "*", "Effect": "Allow", "Condition": { "StringEquals": { "acs:Service": "ecs.aliyuncs.com" } } } ] }

有关创建 RAM 用户和授予权限的更多信息,请参阅 Alibaba Cloud 文档中的 创建 RAM 用户和 Grant 权限。

4.2.2. 配置 Cloud Credential Operator 工具

要分配为每个集群组件提供长期 RAM 访问密钥(AK)的 RAM 用户和策略,请提取并准备 Cloud Credential Operator (CCO) 实用程序 (ccoctl) 二进制文件。

ccoctl 工具是在 Linux 环境中运行的 Linux 二进制文件。

先决条件

- 您可以访问具有集群管理员权限的 OpenShift Container Platform 帐户。

-

已安装 OpenShift CLI(

oc)。

流程

获取 OpenShift Container Platform 发行镜像:

$ RELEASE_IMAGE=$(./openshift-install version | awk '/release image/ {print $3}')从 OpenShift Container Platform 发行镜像获取 CCO 容器镜像:

$ CCO_IMAGE=$(oc adm release info --image-for='cloud-credential-operator' $RELEASE_IMAGE)

注意确保

$RELEASE_IMAGE的架构与将使用ccoctl工具的环境架构相匹配。将 CCO 容器镜像中的

ccoctl二进制文件提取到 OpenShift Container Platform 发行镜像中:$ oc image extract $CCO_IMAGE --file="/usr/bin/ccoctl" -a ~/.pull-secret

更改权限以使

ccoctl可执行:$ chmod 775 ccoctl

验证

要验证

ccoctl是否可以使用,请显示帮助文件:$ ccoctl --help

ccoctl --help的输出OpenShift credentials provisioning tool Usage: ccoctl [command] Available Commands: alibabacloud Manage credentials objects for alibaba cloud aws Manage credentials objects for AWS cloud gcp Manage credentials objects for Google cloud help Help about any command ibmcloud Manage credentials objects for IBM Cloud Flags: -h, --help help for ccoctl Use "ccoctl [command] --help" for more information about a command.

其他资源

4.2.3. 后续步骤

您可以使用以下方法之一在 OpenShift Container Platform 安装程序置备的 Alibaba Cloud 基础架构上安装集群:

- 在 Alibaba Cloud 上快速安装集群:您可以使用默认配置选项快速安装集群。

- 在 Alibaba Cloud 上安装自定义集群 :安装程序允许在安装阶段应用一些自定义。其它自定义选项可在安装后使用。

4.3. 在 Alibaba Cloud 上快速安装集群

在 OpenShift Container Platform 版本 4.10 中,您可以使用默认配置选项在 Alibaba Cloud 上安装集群。

OpenShift Container Platform 上的 Alibaba Cloud 只是一个技术预览功能。技术预览功能不受红帽产品服务等级协议(SLA)支持,且功能可能并不完整。红帽不推荐在生产环境中使用它们。这些技术预览功能可以使用户提早试用新的功能,并有机会在开发阶段提供反馈意见。

有关红帽技术预览功能支持范围的更多信息,请参阅技术预览功能支持范围。

4.3.1. 先决条件

- 您可以参阅有关 OpenShift Container Platform 安装和更新 流程的详细信息。

- 您可以阅读选择集群安装方法并为用户准备它的文档。

- 您已注册了域。

- 如果使用防火墙,将其配置为允许集群需要访问的站点。

- 您已创建了所需的 Alibaba 云资源。

- 如果环境中无法访问云资源访问(RAM)API,或者不想将管理员级别的凭证 secret 存储在 kube-system 命名空间中,您可以手动创建和维护资源访问管理(RAM)凭证。

4.3.2. OpenShift Container Platform 互联网访问

在 OpenShift Container Platform 4.10 中,您需要访问互联网来安装集群。

您必须具有以下互联网访问权限:

- 访问 OpenShift Cluster Manager 以下载安装程序并执行订阅管理。如果集群可以访问互联网,并且没有禁用 Telemetry,该服务会自动授权您的集群。

- 访问 Quay.io,以获取安装集群所需的软件包。

- 获取执行集群更新所需的软件包。

如果您的集群无法直接访问互联网,则可以在置备的某些类型的基础架构上执行受限网络安装。在此过程中,您可以下载所需的内容,并使用它为镜像 registry 填充安装软件包。对于某些安装类型,集群要安装到的环境不需要访问互联网。在更新集群前,您要更新镜像 registry 的内容。

4.3.3. 为集群节点 SSH 访问生成密钥对

在 OpenShift Container Platform 安装过程中,您可以为安装程序提供 SSH 公钥。密钥通过它们的 Ignition 配置文件传递给 Red Hat Enterprise Linux CoreOS(RHCOS)节点,用于验证对节点的 SSH 访问。密钥添加到每个节点上 core 用户的 ~/.ssh/authorized_keys 列表中,这将启用免密码身份验证。

将密钥传递给节点后,您可以使用密钥对作为用户 核心 通过 SSH 连接到 RHCOS 节点。若要通过 SSH 访问节点,必须由 SSH 为您的本地用户管理私钥身份。

如果要通过 SSH 连接到集群节点来执行安装调试或灾难恢复,则必须在安装过程中提供 SSH 公钥。./openshift-install gather 命令还需要在集群节点上设置 SSH 公钥。

不要在生产环境中跳过这个过程,在生产环境中需要灾难恢复和调试。

您必须使用本地密钥,而不是使用特定平台方法配置 的密钥,如 AWS 密钥对。

流程

如果您在本地计算机上没有可用于在集群节点上进行身份验证的现有 SSH 密钥对,请创建一个。例如,在使用 Linux 操作系统的计算机上运行以下命令:

$ ssh-keygen -t ed25519 -N '' -f <path>/<file_name> 1- 1

- 指定新 SSH 密钥的路径和文件名,如

~/.ssh/id_ed25519。如果您已有密钥对,请确保您的公钥位于~/.ssh目录中。

注意如果您计划在

x86_64架构上安装使用 FIPS 验证的/Modules in Process 加密库的 OpenShift Container Platform 集群,请不要创建使用ed25519算法的密钥。相反,创建一个使用rsa或ecdsa算法的密钥。查看公共 SSH 密钥:

$ cat <path>/<file_name>.pub

例如,运行以下命令来查看

~/.ssh/id_ed25519.pub公钥:$ cat ~/.ssh/id_ed25519.pub

将 SSH 私钥身份添加到本地用户的 SSH 代理(如果尚未添加)。在集群节点上,或者要使用

./openshift-install gather命令,需要对该密钥进行 SSH 代理管理,才能在集群节点上进行免密码 SSH 身份验证。注意在某些发行版中,自动管理默认 SSH 私钥身份,如

~/.ssh/id_rsa和~/.ssh/id_dsa。如果

ssh-agent进程尚未为您的本地用户运行,请将其作为后台任务启动:$ eval "$(ssh-agent -s)"

输出示例

Agent pid 31874

注意如果集群处于 FIPS 模式,则只使用 FIPS 兼容算法来生成 SSH 密钥。密钥必须是 RSA 或 ECDSA。

将 SSH 私钥添加到

ssh-agent:$ ssh-add <path>/<file_name> 1- 1

- 指定 SSH 私钥的路径和文件名,如

~/.ssh/id_ed25519.pub

输出示例

Identity added: /home/<you>/<path>/<file_name> (<computer_name>)

后续步骤

- 安装 OpenShift Container Platform 时,为安装程序提供 SSH 公钥。

4.3.4. 获取安装程序

在安装 OpenShift Container Platform 之前,将安装文件下载到本地计算机上。

先决条件

- 您有一台运行 Linux 或 macOS 的计算机,本地磁盘空间为 500 MB

流程

- 访问 OpenShift Cluster Manager 站点的 Infrastructure Provider 页面。如果您有红帽帐户,请使用您的凭证登录。如果没有,请创建一个帐户。

- 选择您的基础架构供应商。

进入到安装类型的页面,下载与您的主机操作系统和架构对应的安装程序,并将该文件放在您要存储安装配置文件的目录中。

重要安装程序会在用来安装集群的计算机上创建几个文件。在完成集群安装后,您必须保留安装程序和安装程序所创建的文件。这两个文件都需要删除集群。

重要删除安装程序创建的文件不会删除您的集群,即使集群在安装过程中失败也是如此。要删除集群,请为特定云供应商完成 OpenShift Container Platform 卸载流程。

提取安装程序。例如,在使用 Linux 操作系统的计算机上运行以下命令:

$ tar -xvf openshift-install-linux.tar.gz

- 从 Red Hat OpenShift Cluster Manager 下载安装 pull secret。此 pull secret 允许您与所含授权机构提供的服务进行身份验证,这些服务包括为 OpenShift Container Platform 组件提供容器镜像的 Quay.io。

4.3.5. 创建安装配置文件

您可以自定义在 Alibaba Cloud 上安装的 OpenShift Container Platform 集群。

先决条件

- 获取 OpenShift Container Platform 安装程序和集群的 pull secret。

- 在订阅级别获取服务主体权限。

流程

创建

install-config.yaml文件。进入包含安装程序的目录并运行以下命令:

$ ./openshift-install create install-config --dir <installation_directory> 1- 1

- 对于

<installation_directory>,请指定要存储安装程序创建的文件的目录名称。

重要指定一个空目录。有些安装资产,如 bootstrap X.509 证书的过期间隔较短,因此不得重复使用安装目录。如果要重复使用另一个集群安装中的单个文件,您可以将它们复制到您的目录中。但是,安装资产的文件名可能会在发行版本间有所变化。从以前的 OpenShift Container Platform 版本中复制安装文件时请小心。

在提示符处,提供云的配置详情:

可选: 选择用于访问集群机器的 SSH 密钥。

注意对于您要在其上执行安装调试或灾难恢复的生产环境 OpenShift Container Platform 集群,请指定

ssh-agent进程使用的 SSH 密钥。- 选择 alibabacloud 作为目标平台。

- 选择要将集群部署到的区域。

- 选择集群要部署到的基域。基域与您为集群创建的公共 DNS 区对应。

- 为集群提供一个描述性名称。

- 粘贴 Red Hat OpenShift Cluster Manager 中的 pull secret。

将集群安装到 Alibaba Cloud 中需要 Cloud Credential Operator(CCO)以手动模式运行。修改

install-config.yaml文件,将credentialsMode参数设置为Manual:带有

credentialsMode被设置为Manual的 install-config.yaml 配置文件示例apiVersion: v1 baseDomain: cluster1.example.com credentialsMode: Manual 1 compute: - architecture: amd64 hyperthreading: Enabled ...- 1

- 添加此行,将

credentialsMode设置为Manual。

备份

install-config.yaml文件,以便您可以使用它安装多个集群。重要install-config.yaml文件会在安装过程中消耗掉。如果要重复使用该文件,您必须立即备份该文件。

4.3.6. 生成所需的安装清单

您必须生成 Kubernetes 清单和 Ignition 配置文件,集群需要配置机器。

流程

从包含安装程序的目录中运行以下命令来生成清单:

$ openshift-install create manifests --dir <installation_directory>

其中:

<installation_directory>- 指定安装程序在其中创建文件的目录。

4.3.7. 使用 ccoctl 工具为 OpenShift Container Platform 组件创建凭证

您可以使用 OpenShift Container Platform Cloud Credential Operator(CCO)实用程序自动为每个集群组件创建 Alibaba Cloud RAM 用户和策略。

默认情况下,ccoctl 在运行命令的目录中创建对象。要在其他目录中创建对象,请使用 --output-dir 标志。此流程使用 <path_to_ccoctl_output_dir> 来引用这个目录。

先决条件

您必须:

-

提取并准备好

ccoctl二进制文件。 - 创建具有足够权限来创建 OpenShift Container Platform 集群的 RAM 用户。

-

将 RAM 用户的 AccessKeyID(

access_key_id)和 AccessKeySecret(access_key_secret)添加到本地计算机上的~/.alibabacloud/credentials文件中。

流程

运行以下命令设置

$RELEASE_IMAGE变量:$ RELEASE_IMAGE=$(./openshift-install version | awk '/release image/ {print $3}')运行以下命令,从 OpenShift Container Platform 发行镜像中提取

CredentialsRequest对象列表:$ oc adm release extract \ --credentials-requests \ --cloud=alibabacloud \ --to=<path_to_directory_with_list_of_credentials_requests>/credrequests \ 1 $RELEASE_IMAGE- 1

credrequests是存储CredentialsRequest对象列表的目录。如果该目录不存在,此命令就会创建该目录。

注意运行此命令可能需要一些时间。

如果您的集群使用集群功能禁用一个或多个可选组件,请删除任何禁用组件的

CredentialsRequest自定义资源。Alibaba Cloud 上 OpenShift Container Platform 4.12 的

credrequests目录的内容示例0000_30_machine-api-operator_00_credentials-request.yaml 1 0000_50_cluster-image-registry-operator_01-registry-credentials-request-alibaba.yaml 2 0000_50_cluster-ingress-operator_00-ingress-credentials-request.yaml 3 0000_50_cluster-storage-operator_03_credentials_request_alibaba.yaml 4

使用

ccoctl工具处理credrequests目录中的所有CredentialsRequest对象:运行以下命令使用该工具:

$ ccoctl alibabacloud create-ram-users \ --name <name> \ --region=<alibaba_region> \ --credentials-requests-dir=<path_to_directory_with_list_of_credentials_requests>/credrequests \ --output-dir=<path_to_ccoctl_output_dir>

其中:

-

<name>是用于标记为跟踪而创建的云资源的名称。 -

<alibaba_region>是创建云资源的 Alibaba Cloud 区域。 -

<path_to_directory_with_list_of_requests>/credrequests是含有组件CredentialsRequest对象的文件的目录。 -

<path_to_ccoctl_output_dir>是放置所生成的组件凭证 secret 的目录。

注意如果您的集群使用

TechPreviewNoUpgrade功能集启用的技术预览功能,则必须包含--enable-tech-preview参数。输出示例