Red Hat Training

A Red Hat training course is available for OpenShift Container Platform

开发人员指南

OpenShift Container Platform 3.9 开发人员参考

摘要

第 1 章 概述

本指南面向应用程序开发人员,提供设置和配置工作站在 OpenShift Container Platform 云环境中开发和部署应用程序的说明。这包括帮助开发人员的详细说明和示例:

第 2 章 应用程序生命周期管理

2.1. 规划您的开发流程

2.1.1. 概述

OpenShift Container Platform 专为构建和部署应用程序而设计。根据开发过程中涉及的 OpenShift Container Platform 量,您可以选择:

- 专注于 OpenShift Container Platform 项目中的开发,使用它从头开始构建应用,然后持续开发和管理其生命周期,或者

- 使应用程序(如二进制、容器镜像、源代码)已在单独的环境中开发,并将其部署到 OpenShift Container Platform。

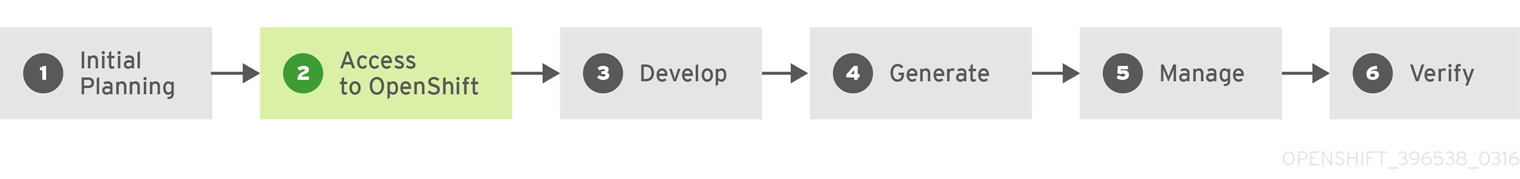

2.1.2. 使用 OpenShift Container Platform 作为您的开发环境

您可以直接使用 OpenShift Container Platform 从头开始开始应用程序的开发。在规划此类型的开发过程中请考虑以下步骤:

初始规划

- 您的应用程序有什么作用?

- 将在什么编程语言中开发?

访问 OpenShift Container Platform

- OpenShift Container Platform 应该由您自己或您所在机构的管理员安装。

开发

- 使用您的编辑器或选择的 IDE,创建一个应用程序的基本框架。它应该足以告知 OpenShift Container Platform 是什么应用程序。

- 将代码推送到您的 Git 存储库。

Generate

-

使用

oc new-app命令创建基本应用程序。OpenShift Container Platform 生成构建和部署配置。

管理

- 开始开发您的应用程序代码。

- 确保您的应用构建成功。

- 继续在本地开发和管理您的代码。

- 将您的代码推送到 Git 存储库。

- 是否需要额外的配置?更多相关信息,请参阅开发人员指南。

验证

-

您可以通过多种方法验证您的应用程序。您可以将更改推送到应用程序的 Git 存储库,并使用 OpenShift Container Platform 重建并重新部署应用程序。另外,您可以使用

rsync热部署将代码更改同步到正在运行的 pod。

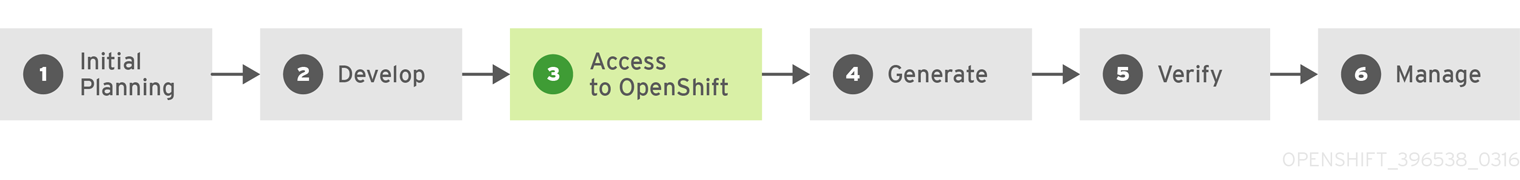

2.1.3. 使应用程序能够部署到 OpenShift Container Platform

另一种可能的应用程序开发策略是在本地开发,然后使用 OpenShift Container Platform 部署您完全开发的应用程序。如果计划已有应用程序代码,请使用以下步骤,然后在完成后构建并部署到 OpenShift Container Platform 安装中:

初始规划

- 您的应用程序有什么作用?

- 将在什么编程语言中开发?

开发

- 使用您的编辑器或您选择的 IDE 开发您的应用程序代码。

- 本地构建并测试应用程序代码。

- 将您的代码推送到 Git 存储库。

访问 OpenShift Container Platform

- OpenShift Container Platform 应该由您自己或您所在机构的管理员安装。

Generate

-

使用

oc new-app命令创建基本应用程序。OpenShift Container Platform 生成构建和部署配置。

验证

- 确保已在以上 Generate 步骤中构建和部署的应用程序在 OpenShift Container Platform 上成功运行。

管理

- 继续开发应用程序代码,直到您对此结果很满意。

- 在 OpenShift Container Platform 中重新构建您的应用程序,以接受任何新推送的代码。

- 是否需要额外的配置?更多相关信息,请参阅开发人员指南。

2.2. 创建新应用程序

2.2.1. 概述

您可以使用 OpenShift CLI 或 Web 控制台,从包括源代码或二进制代码、镜像和/或模板在内的组件创建一个新的 OpenShift Container Platform 应用程序。

2.2.2. 使用 CLI 创建应用程序

2.2.2.1. 从源代码创建应用程序

您可以使用 new-app 命令从本地或远程 Git 存储库中的源代码创建应用程序。

使用本地目录中的 Git 存储库创建应用程序:

$ oc new-app /path/to/source/code

如果使用本地 Git 存储库,该存储库应具有一个名为 origin 的远程源,指向 OpenShift Container Platform 集群可访问的 URL。如果没有 recognized remote,new-app 将创建一个 二进制构建。

使用远程 Git 存储库创建应用程序:

$ oc new-app https://github.com/sclorg/cakephp-ex

使用私有远程 Git 存储库创建应用程序:

$ oc new-app https://github.com/youruser/yourprivaterepo --source-secret=yoursecret

如果使用私有远程 Git 存储库,您可以使用 --source-secret 标志指定一个现有的 source clone secret,该 secret 将注入到 BuildConfig 中以访问存储库。

您可以通过指定 --context-dir 标志来使用源代码存储库的子目录。使用远程 Git 存储库和上下文子目录创建应用程序:

$ oc new-app https://github.com/sclorg/s2i-ruby-container.git \

--context-dir=2.0/test/puma-test-app

另外,在指定远程 URL 时,您可以通过在 URL 末尾附加 #<branch_name> 来指定要使用的 Git 分支:

$ oc new-app https://github.com/openshift/ruby-hello-world.git#beta4

new-app 命令将创建一个构建配置,它本身会从您的源代码中创建一个新的应用程序镜像。new-app 命令通常还会创建用于部署新镜像的部署配置,以及为运行您的镜像的部署提供负载均衡访问的服务。

OpenShift Container Platform 会自动 检测 是否应使用 Docker、Pipeline 或 Source 构建策略,如果进行 Source 构建,则 检测相应的语言构建器镜像。

构建策略检测

在创建新应用程序时,如果源存储库的根目录或指定上下文目录中存在 Jenkinsfile,则 OpenShift Container Platform 会生成 Pipeline 构建策略。否则,如果找到 Dockerfile,OpenShift Container Platform 会生成 Docker 构建策略。否则,它会生成 Source 构建策略。

您可以通过将 --strategy 标志设置为 docker、pipeline 或 source 来覆盖构建策略。

$ oc new-app /home/user/code/myapp --strategy=docker

oc 命令要求包含构建源的文件在远程 Git 存储库中可用。对于所有 Source 构建,您必须使用 git remote -v。

语言检测

如果使用 Source 构建策略,new-app 会尝试根据存储库根目录或指定上下文目录中是否存在特定文件来确定要使用的语言构建器:

表 2.1. new-app 检测的语言

| 语言 | 文件 |

|---|---|

|

| project.json, *.csproj |

|

| pom.xml |

|

| app.json, package.json |

|

| cpanfile, index.pl |

|

| composer.json, index.php |

|

| requirements.txt, setup.py |

|

| Gemfile, Rakefile, config.ru |

|

| build.sbt |

|

| Godeps, main.go |

检测了语言后,new-app 会在 OpenShift Container Platform 服务器上搜索具有与所检测语言匹配的支持注解的镜像流标签,或与所检测语言名称匹配 的镜像流。如果找不到匹配项,new-app 会在 Docker Hub registry 中搜索名称上与所检测语言匹配的镜像。

您可以通过指定镜像(镜像流或容器规格)和存储库(以 ~ 作为分隔符),来覆盖构建器用于特定源存储库的镜像。请注意,如果这样做,不会执行 构建策略检测和语言检测。

例如,将 myproject/my-ruby 镜像流与远程存储库中的源一起使用:

$ oc new-app myproject/my-ruby~https://github.com/openshift/ruby-hello-world.git

使用 openshift/ruby-20-centos7:latest 容器镜像流以及本地仓库中的源:

$ oc new-app openshift/ruby-20-centos7:latest~/home/user/code/my-ruby-app

2.2.2.2. 从镜像创建应用程序

您可以从现有镜像部署应用程序。镜像可以来自 OpenShift Container Platform 服务器中的镜像流、特定 registry 或 Docker Hub registry 中的镜像,或本地 Docker 服务器中的镜像。

new-app 命令尝试确定传递给它的参数中指定的镜像类型。但是,您可以明确告知 new-app 镜像是 Docker 镜像(使用 --docker-image 参数)还是镜像流(使用 -i|--image 参数)。

如果指定本地 Docker 存储库中的镜像,必须确保同一镜像可供 OpenShift Container Platform 节点使用。

例如,从 DockerHub MySQL 镜像创建应用程序:

$ oc new-app mysql

要使用私有 registry 中的镜像创建应用程序,请指定完整的 Docker 镜像规格:

$ oc new-app myregistry:5000/example/myimage

如果包含镜像的 registry 没有使用 SSL 保护,集群管理员必须确保 OpenShift Container Platform 节点主机上的 Docker 守护进程使用指向该 registry 的 --insecure-registry 标志运行。您还必须告知 new-app 镜像来自带有 --insecure-registry 标志的不安全 registry。

$ oc new-app my-stream:v1

2.2.2.3. 从模板创建应用程序

您可以通过将 模板名称 指定为参数,从之前存储的模板或模板文件创建应用程序。例如,您可以存储一个示例应用程序模板,并使用它来创建应用程序。

从存储的模板创建应用程序:

$ oc create -f examples/sample-app/application-template-stibuild.json $ oc new-app ruby-helloworld-sample

要直接使用本地文件系统中的模板,而不先将它保存到 OpenShift Container Platform 中,请使用 -f|--file 参数:

$ oc new-app -f examples/sample-app/application-template-stibuild.json

模板参数

在基于模板创建应用程序时,请使用 -p|--param 参数来设置模板定义的参数值:

$ oc new-app ruby-helloworld-sample \

-p ADMIN_USERNAME=admin -p ADMIN_PASSWORD=mypassword

您可以将参数保存到文件中,然后在实例化模板时通过 --param-file 来使用该文件。如果要从标准输入中读取参数,请使用 --param-file=-:

$ cat helloworld.params ADMIN_USERNAME=admin ADMIN_PASSWORD=mypassword $ oc new-app ruby-helloworld-sample --param-file=helloworld.params $ cat helloworld.params | oc new-app ruby-helloworld-sample --param-file=-

2.2.2.4. 进一步修改应用程序创建

new-app 命令生成将构建、部署和运行正在创建应用程序的 OpenShift Container Platform 对象。通常,这些对象使用从输入源存储库或输入镜像派生的名称在当前项目中创建。但是,new-app 允许您修改此行为。

由 new-app 创建的对象集合取决于作为输入传递的工件,如输入源存储库、镜像或模板。

表 2.2. new-app 输出对象

| 对象 | 描述 |

|---|---|

|

|

为命令行中指定的每个源存储库创建一个 |

|

|

对于 |

|

|

创建一个 |

|

|

|

| 其他 | 根据模板,可在实例化模板时生成其他对象。 |

2.2.2.4.1. 指定环境变量

从模板、源 或 镜像 生成应用程序时,您可以在运行时使用 -e|--env 参数将环境变量传递给应用程序容器:

$ oc new-app openshift/postgresql-92-centos7 \

-e POSTGRESQL_USER=user \

-e POSTGRESQL_DATABASE=db \

-e POSTGRESQL_PASSWORD=password

这些变量可使用 --env-file 参数从文件中读取:

$ cat postgresql.env POSTGRESQL_USER=user POSTGRESQL_DATABASE=db POSTGRESQL_PASSWORD=password $ oc new-app openshift/postgresql-92-centos7 --env-file=postgresql.env

另外,也可使用 --env-file=- 在标准输入上给定环境变量:

$ cat postgresql.env | oc new-app openshift/postgresql-92-centos7 --env-file=-

如需更多信息,请参阅管理环境变量。

在 new-app 处理过程中创建的任何 BuildConfig 对象,都不能使用通过 -e|--env 或 --env-file 参数传递的环境变量进行更新。

2.2.2.4.2. 指定构建环境变量

从模板、源 或 镜像 生成应用程序时,您可以在运行时使用 --build-env 参数将环境变量传递给构建容器:

$ oc new-app openshift/ruby-23-centos7 \

--build-env HTTP_PROXY=http://myproxy.net:1337/ \

--build-env GEM_HOME=~/.gem

这些变量可使用 --build-env-file 参数从文件中读取:

$ cat ruby.env HTTP_PROXY=http://myproxy.net:1337/ GEM_HOME=~/.gem $ oc new-app openshift/ruby-23-centos7 --build-env-file=ruby.env

另外,也可使用 --build-env-file=- 在标准输入上给定环境变量:

$ cat ruby.env | oc new-app openshift/ruby-23-centos7 --build-env-file=-

2.2.2.4.3. 指定标签

从源、镜像或模板生成 应用程序时,您可以使用 -l|--label 参数向创建的对象添加标签。借助标签,您可以轻松地集中选择、配置和删除与应用程序关联的对象。

$ oc new-app https://github.com/openshift/ruby-hello-world -l name=hello-world

2.2.2.4.4. 查看输出(不创建)

要查看要创建的 new-app 的空运行,您可以使用 -o|--output 参数及 yaml 或 json 值。然后,您可以使用输出来预览要创建的对象,或者将其重定向到您可以编辑的文件。满意后,您可以使用 oc create 创建 OpenShift Container Platform 对象。

将 new-app 工件输出到文件中,编辑工件,再创建工件:

$ oc new-app https://github.com/openshift/ruby-hello-world \

-o yaml > myapp.yaml

$ vi myapp.yaml

$ oc create -f myapp.yaml2.2.2.4.5. 使用不同名称创建对象

new-app 创建的对象通常命名自用于生成它们的源存储库或镜像。您可以通过在命令中添加 --name 标志来设置生成的对象名称:

$ oc new-app https://github.com/openshift/ruby-hello-world --name=myapp

2.2.2.4.6. 在不同的项目中创建对象

通常,new-app 会在当前项目中创建对象。但是,您可以使用 -n|--namespace 参数在有权访问的不同项目中创建对象:

$ oc new-app https://github.com/openshift/ruby-hello-world -n myproject

2.2.2.4.7. 创建多个对象

new-app 命令允许创建多个应用程序,为 new-app 指定多个参数便可实现。命令行中指定的标签将应用到单一命令创建的所有对象。环境变量应用到从源或镜像创建的所有组件。

从源存储库和 Docker Hub 镜像创建应用程序:

$ oc new-app https://github.com/openshift/ruby-hello-world mysql

如果以独立参数形式指定源代码存储库和构建器镜像,new-app 会将构建器镜像用作源代码存储库的构建器。如果这不是您的用意,请使用 ~ 分隔符为源指定所需的构建器镜像。

2.2.2.4.8. 在单个 Pod 中对镜像和源进行分组

new-app 命令允许在一个 pod 中一起部署多个镜像。要指定哪些镜像要分组在一起,请使用 + 分隔符。也可使用 --group 命令行参数来指定应分组在一起的镜像。要将源存储库中构建的镜像与其他镜像一起分组,请在组中指定其构建器镜像:

$ oc new-app ruby+mysql

将通过源构建的镜像和外部镜像一起部署:

$ oc new-app \

ruby~https://github.com/openshift/ruby-hello-world \

mysql \

--group=ruby+mysql2.2.2.4.9. 搜索镜像、模板和其他输入

要搜索镜像、模板和 oc new-app 命令的其他输入,使用 --search 和 --list。例如,查找包含 PHP 的所有镜像或模板:

$ oc new-app --search php

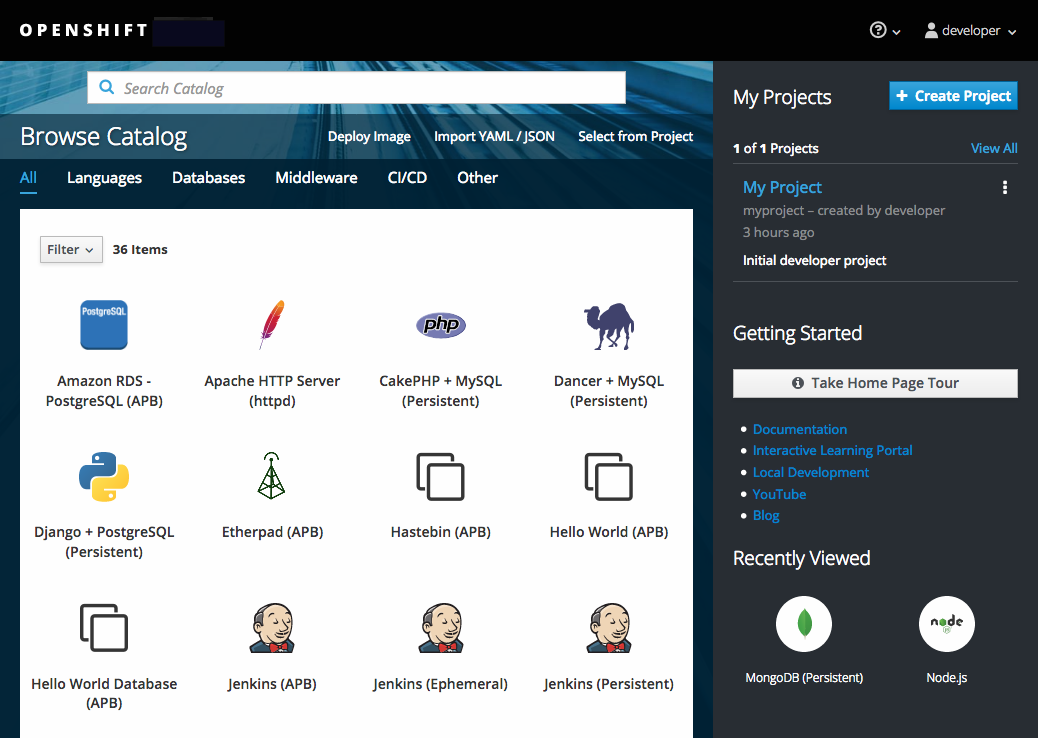

2.2.3. 使用 Web 控制台创建应用程序

在所需项目中,点击 Add to Project :

从项目中的镜像列表或从服务目录中选择构建程序镜像。

注意

注意只有其注解中列出 builder 标签的 image stream tags 才会出现在此列表中,如下所示:

kind: "ImageStream" apiVersion: "v1" metadata: name: "ruby" creationTimestamp: null spec: dockerImageRepository: "registry.access.redhat.com/openshift3/ruby-20-rhel7" tags: - name: "2.0" annotations: description: "Build and run Ruby 2.0 applications" iconClass: "icon-ruby" tags: "builder,ruby" 1 supports: "ruby:2.0,ruby" version: "2.0"- 1

- 此处包含 builder 可确保该

ImageStreamTag作为构建程序出现在 web 控制台中。

修改新应用程序屏幕中的设置,以配置对象来支持您的应用程序:

2.3. 在跨环境中提升应用程序

2.3.1. 概述

应用程序提升意味着通过各种运行时环境迁移应用程序,通常具有更高程度的成熟度。例如,应用程序可能会在开发环境中启动,然后提升到暂存环境以进一步进行测试,然后才会出现在生产环境中。随着应用中引入的变化,再次更改将在开发中开始,并在 stage 和生产环境中推广。

当今的"应用程序"不仅仅是使用 Java、Perl 和 Python 等编写的源代码。现在,它比静态 Web 内容、集成脚本或应用特定运行时的相关配置更多。它不仅仅是由那些语言特定运行时使用的应用程序特定存档。

在 OpenShift Container Platform 及其 Kubernetes 和 Docker 的组合部分中,额外的应用程序工件包括:

- Docker 容器镜像 及其丰富的元数据和相关工具。

- 注入容器的环境变量以供应用程序使用。

API 对象 (也称为资源定义);请参阅 OpenShift Container Platform 的核心概念,它:

- 注入到容器中供应用使用。

- OpenShift Container Platform 如何管理容器和 pod。

在 OpenShift Container Platform 中如何推广应用程序,这个主题将:

- 详细阐述引入到应用程序定义中的这些新工件。

- 描述您可以为应用程序提升管道分离不同的环境。

- 讨论用于管理这些新工件的方法和工具。

- 提供将各种概念、构建、方法和工具应用到应用程序提升的示例。

2.3.2. 应用程序组件

2.3.2.1. API 对象

对于 OpenShift Container Platform 和 Kubernetes 资源定义(新向应用程序清单引入的项目),这些 API 对象有几个关键设计点,在考虑应用程序提升主题时,需要重新查看这些 API 对象。

首先,作为在 OpenShift Container Platform 文档中突出显示的,每个 API 对象可以通过 JSON 或 YAML 来表达,从而可以通过传统的源控制和脚本管理这些资源定义。

另外,API 对象也被设计为设计为存在部分对象,用于指定系统所需状态,其他部分则反映了系统的状态或当前状态。这可以被认为为输入和输出。以 JSON 或 YAML 格式表示的输入部分,特别是作为源控制管理(SCM)工件自然而符合的项目。

请记住,API 对象的输入或规格部分可以全面静态或动态,该变量在实例化时 可以通过模板处理替换。

与 API 对象相关的结果是,其表达式用作 JSON 或 YAML 文件,您可以将应用程序的配置视为代码。

可以说,几乎所有 API 对象都可能会被视为您的机构的应用程序工件。下面是与部署和管理应用程序最常见相关的对象:

- BuildConfig

-

在应用程序提升的情况下是一个特殊情况资源。虽然

BuildConfig是应用程序的一部分,特别是开发人员透视图中,但通常BuildConfig不会通过管道来提升。它会生成通过管道提升(以及其他项目)的镜像。 - 模板

-

在应用程序提升方面,

模板可以充当在给定暂存环境中设置资源的起点,特别是参数化功能。当应用程序通过提升管道进行移动时,额外的后后修改会非常有效。有关此方面的更多信息,请参阅场景和示例。 - Routes

-

这些是应用程序提升管道中阶段阶段的最典型资源,作为通过其

Route对应用程序的不同阶段进行测试。另外,请记住,您拥有与手动规格或自动生成主机名相关的选项,以及Route的 HTTP 级别的安全性。 - 服务

-

对于给定应用程序提升阶段存在避免

Routers和Routes的原因(例如在开发的早期阶段为开发人员提供简便),可以通过集群IP 地址和端口访问应用程序。如果是这种情况,则在不同阶段之间的地址和端口的某些管理可能需要保证。 - Endpoints

-

某些应用程序级别服务(例如,许多企业中的数据库实例)可能无法由 OpenShift Container Platform 管理。如果是这样,则自行创建这些

端点,以及对相关服务(忽略Service上的选择器字段)的修改已启用(基于您的具体环境,在不同阶段之间重复或共享)。 - Secrets

-

当相应实体(由 OpenShift Container Platform 管理的

服务或 OpenShift Container Platform 之外的外部服务管理的服务)时,由Secret封装的敏感信息是在暂存环境之间共享的。如果您的应用程序提升管道的不同阶段有不同版本的实体,则可能需要在管道的每个阶段维护不同的Secret,或者在它遍历管道时对其进行修改。另外,请注意,如果您在 SCM 中将Secret存储为 JSON 或 YAML,则可能会对一些加密格式进行加密,以保护敏感信息。 - DeploymentConfig

- 此对象是用于定义和缩进给定应用程序提升管道阶段的环境的主要资源;它控制应用程序启动的方式。虽然所有不同阶段都很常见,但为了加快应用程序的提升管道进行,但撤销会对这个对象进行修改,以反映每个阶段的不同环境的不同,或者系统行为的变化,以协助测试应用程序必须支持的不同场景。

- ImageStream、ImageStreamTags 和 ImageStreamImage

- 在 Images 和 Image Streams 部分中详述,这些对象是管理容器镜像的 OpenShift Container Platform 补充。

- ServiceAccounts 和 RoleBindings

-

OpenShift Container Platform 中其他 API 对象的权限管理以及外部服务,用于管理您的应用程序。与

Secrets类似,ServiceAccounts和RoleBindings对象可能会因您需要共享或隔离这些不同环境的需求在应用程序提升管道的不同阶段之间共享的不同而有所不同。 - PersistentVolumeClaims

- 与数据库等有状态服务相关,不同的应用程序提升阶段将共享量与您的组织共享或隔离应用程序数据副本的关联。

- ConfigMaps

-

从

Pod本身分离Pod配置的一个实用性(思考环境变量风格配置)可在需要一致的Pod行为时由各种暂存环境共享。它们也可以在阶段修改,以更改Pod行为(通常因为应用程序的不同方面被检查到不同的阶段)。

2.3.2.2. 镜像

如前所述,容器镜像现在是应用程序的工件。事实上,新应用工件、镜像和管理是应用程序提升的关键部分。在某些情况下,镜像可能会封装整个应用,应用提升流程则专门管理镜像。

镜像通常不在 SCM 系统中管理,因为应用二进制文件不在以前的系统中。但是,正如二进制文件、可安装的工件和相应的存储库(即 RPM、RPM 存储库、Nexus 等)与 SCM 类似,类似 SCM 的语义,类似与 SCM 类似的镜像管理结构和术语:

- 镜像 registry == SCM 服务器

- 镜像存储库 == SCM 存储库

当镜像位于 registry 中时,需要确保 registry 中存在适当的镜像,这些镜像可从需要运行该镜像代表的应用程序的环境中访问。

应用程序定义通常抽象到镜像流的引用,而不是直接引用镜像。这意味着镜像流将是组成应用程序组件的另一个 API 对象。有关镜像流的详情,请参阅 核心概念。

2.3.2.3. 概述

现在,在 OpenShift Container Platform 内应用程序推广应用程序工件、镜像和 API 对象的应用程序工件已包括在 OpenShift Container Platform 中,您在提升管道的不同阶段运行应用程序的行为是接下来讨论的。

2.3.3. 部署环境

在这种情况下,部署环境描述了在 CI/CD 管道的特定阶段运行应用程序的不同空间。典型环境包括 开发、测试、stage 和生产,例如:环境边界可以以不同的方式定义,例如:

- 通过单一项目中的标签和唯一命名。

- 通过集群中的不同项目。

- 通过不同的集群。

它取决于您的组织是否全部利用了所有三个产品。

2.3.3.1. 注意事项

通常,您会在部署环境结构时考虑以下 heuristics:

- 共享您的提升流程的不同阶段的资源量允许

- 隔离您的提升流程的不同阶段需要多少

- 如何集中位置(或地理位置分散的)促销流程的不同阶段

另外,一些重要的提醒有关 OpenShift Container Platform 集群和项目与镜像 registry 的关系:

- 同一集群中的多个项目可以访问同一镜像流。

- 多个集群可以访问同一外部 registry。

- 只有 OpenShift Container Platform 内部镜像 registry 通过路由公开时,集群才可以共享 registry。

2.3.3.2. 概述

定义了部署环境后,可以实施管道中的下线阶段的提升流程。构造这些提升流实施的方法和工具是下一个讨论点。

2.3.4. 方法和工具

从根本上而言,应用程序提升是一种将上述应用程序组件从一个环境移至另一个环境的过程。以下小节概述了可用于手动移动各种组件的工具,然后再讨论用于自动化应用程序提升的完整解决方案。

构建和部署过程中都提供了很多插入点。它们在 BuildConfig 和 DeploymentConfig API 对象中定义。这些 hook 允许调用与部署的组件(如数据库和 OpenShift Container Platform 集群本身)交互的自定义脚本。

因此,可以使用这些 hook 来执行组件管理操作,在环境间有效移动应用程序,例如,从 hook 中执行镜像标签操作。但是,各种 hook 得分最适合在给定环境中管理应用程序的生命周期(例如,在部署新版本的应用程序时执行数据库架构迁移),而不是在环境之间移动应用程序组件。

2.3.4.1. 管理 API 对象

在单一环境中定义的资源将导出为 JSON 或 YAML 文件内容,以准备将其导入到新环境中。因此,当您通过应用程序管道提升 API 对象时,作为 JSON 或 YAML 的表达式作为工作单元。oc CLI 用于导出和导入此内容。

虽然在 OpenShift Container Platform 中不需要提升流,但 JSON 或 YAML 存储在文件中,但您可以考虑从 SCM 系统中存储和检索内容。这可让您利用 SCM 的与版本相关的功能,包括创建分支,以及针对与版本关联的不同标签或标签分配和查询。

2.3.4.1.1. 导出 API 对象状态

可以通过 oc export 捕获 API 对象规格。此操作会从对象定义(如当前命名空间或分配的 IP 地址)中移除环境特定数据,允许在不同环境中重新创建它们(与 oc get 操作不同,它输出对象的不过滤状态)。

使用 oc label,它允许在 API 对象上添加、修改或删除标签,这在组织为提升流程而收集的一组对象时很有用,因为标签允许在单一操作中选择和管理 pod 组。这样可以更轻松地导出正确组的对象,因为标签将在新环境中创建对象时向前工作,所以它们还可以更轻松地管理每个环境中的应用程序组件。

API 对象通常包含引用 Secret 的 DeploymentConfig 等。当将 API 对象从一个环境迁移到另一个环境时,您必须确保这样的引用也会移到新环境中。

同样,DeploymentConfig 等 API 对象通常包含引用外部 registry 的 ImageStream 的引用。当将 API 对象从一个环境移到另一个环境时,您必须确保在新环境中可以解析此类引用,这意味着引用必须可以被解析,并且 ImageStream 必须引用新环境中可访问的 registry。如需了解更多详细信息,请参阅 Moving Images 和 Promotion Caveats。

2.3.4.1.2. 导入 API 对象状态

2.3.4.1.2.1. 初始创建

当应用程序第一次出现在新环境中时,使用 JSON 或 YAML 来表达 API 对象规格,并运行 oc create 在适当的环境中创建它们。使用 oc create 时,请记住 --save-config 选项。在其注解列表中保存对象的配置元素有助于稍后使用 oc apply 修改对象。

2.3.4.1.2.2. 迭代修改

最初建立各种暂存环境后,在提升周期开始并且应用程序从阶段移到 stage 后,对应用程序的更新会包括修改作为应用程序一部分的 API 对象。这些 API 对象中的更改是可激活的,因为它们代表 OpenShift Container Platform 系统的配置。这种变化的动机包括:

- 衡量暂存环境之间的环境差异。

- 验证应用支持的各种场景。

API 对象传输到下一阶段的环境可以通过 oc CLI 来完成。虽然存在修改 API 对象的多组 oc 命令,但此主题侧重于 oc apply,其计算并应用对象之间的差别。

特别是,您可以把 oc apply 作为三向合并,在文件或 stdin 中取为输入以及现有的对象定义。它执行三向合并:

- 命令的输入,

- 对象的当前版本,以及

- 最近的用户指定的对象定义存储为当前对象中的注解。

然后,使用结果更新现有对象。

如果需要进一步自定义 API 对象,如在源和目标环境之间对象不能相同时,可以使用 oc set 等 oc 命令在应用来自上游环境的最新对象定义后修改对象。

某些特定的用途在 Scenarios 和示例中加以控制。

2.3.4.2. 管理镜像和镜像流

OpenShift Container Platform 中的镜像也通过一系列 API 对象进行管理。但是,管理镜像是应用程序提升的核心,讨论这些工具和 API 对象最直接关联镜像保证了单独讨论。存在手动和自动化的形式,可帮助您管理镜像提升(通过管道传播镜像)。

2.3.4.2.1. 移动镜像

有关管理镜像的所有详细信息,请参阅管理镜像主题。

2.3.4.2.1.1. 当暂存环境共享 registry 时

当暂存环境共享相同的 OpenShift Container Platform registry 时,例如它们都在同一个 OpenShift Container Platform 集群中,则有两个操作,代表在应用程序提升管道的不同 stage 间移动镜像:

-

首先,与

docker tag和git tag类似,oc tag命令允许您更新具有特定镜像的 OpenShift Container Platform 镜像流。它还允许您将引用从一个镜像流的特定版本复制到另一个镜像流,即使在集群中的不同项目也是如此。 -

其次,

oc import-image充当外部 Registry 和镜像流之间的桥接。它从 registry 中导入给定镜像的元数据,并将其作为镜像流标签存储在镜像流中。项目中的各种BuildConfigs和DeploymentConfig可以引用这些特定的镜像。

2.3.4.2.1.2. 当 Staging 环境使用不同的 registry 时

当 staging 环境使用不同的 OpenShift Container Platform registry 时,会进行更高级的使用。访问内部 registry 会详细介绍这些步骤,但总体来说您可以:

-

使用

docker命令组合获取 OpenShift Container Platform 访问令牌,以提供docker login命令。 -

登录 OpenShift Container Platform registry 后,请使用

docker pull、docker tag和docker push来传输镜像。 -

在管道下一环境的 registry 中提供了镜像后,根据需要使用

oc tag来填充任何镜像流。

2.3.4.2.2. 部署

无论是更改底层应用程序镜像还是配置应用程序的 API 对象,部署通常需要提取升级的更改。如果应用程序的镜像改变(例如,由于 oc tag 操作或 docker push 作为从上游环境提升镜像的一部分),则您的 DeploymentConfig 上的 ImageChangeTriggers 可以触发新部署。同样,如果 DeploymentConfig API 对象本身被更改,则当由提升步骤更新 API 对象时,ConfigChangeTrigger 可以启动部署(如 oc apply)。

否则,有助于手动部署的 oc 命令包括:

-

oc rollout:管理部署的新方法,包括暂停和恢复语义以及有关管理历史记录的丰富功能。 -

oc rollback:允许重新升级到以前的部署 ; 在升级场景中,如果测试新版本遇到问题,请确认它仍可用于上一版本。

2.3.4.2.3. 使用 Jenkins 自动化促销流

在了解了应用程序的组件后,在提升环境以及移动组件所需的步骤时需要在环境间进行移动后,您可以开始编配和自动化工作流。OpenShift Container Platform 提供了一个 Jenkins 镜像和插件来解决此问题。

使用镜像 (image)中详细介绍了 OpenShift Container Platform Jenkins 镜像,其中包括有助于 Jenkins 集成 Jenkins 和 Jenkins Pipelines 的 OpenShift Container Platform 以插件集。另外,Pipeline 构建策略 有助于集成 Jenkins Pipelines 和 OpenShift Container Platform。所有这些侧重于启用 CI/CD 的各个方面,包括应用程序提升。

在手动执行应用程序提升步骤外,应该考虑 OpenShift Container Platform 提供的与 Jenkins 相关的功能:

- OpenShift Container Platform 提供了一个 Jenkins 镜像,它被定制来大大简化 OpenShift Container Platform 集群中的部署。

- Jenkins 镜像包含 OpenShift Pipeline 插件,它为实施提升工作流提供构建块。这些构建块包括 Jenkins 任务触发作为镜像流更改,以及在这些作业中触发构建和部署。

-

采用 OpenShift Container Platform Jenkins Pipeline 构建策略的

BuildConfig可执行基于 Jenkinsfile 的 Jenkins 管道作业。Pipeline 作业是 Jenkins 中用于复杂提升流程的战略方向,可以利用 OpenShift Pipeline 插件提供的步骤。

2.3.4.2.4. Promotion Caveats

2.3.4.2.4.1. API 对象参考

API 对象可以引用其他对象。这种情况的一个常见用途是具有引用镜像流的 DeploymentConfig,但也有其他引用关系。

将 API 对象从一个环境复制到另一个环境时,所有引用仍可以在目标环境中解析。有几个参考场景需要考虑:

- 引用是项目的"本地"。在这种情况下,引用的对象位于与引用它的对象位于同一项目中。通常,要进行的正确操作是,请确保将引用的对象复制到与引用对象相同的项目中的目标环境中。

引用是另一个项目中的对象。当多个应用程序项目使用共享项目中的镜像流时(请参阅 管理镜像)时,这通常是。在这种情况下,当将引用对象复制到新环境中时,您必须根据需要更新引用,以便在目标环境中解析它。这可能意味着:

- 如果共享项目在目标环境中具有不同的名称,则更改引用指向的项目。

- 将引用对象从目标环境中的本地项目移动到本地项目,并将主对象移到目标环境中时,将引用更新为指向本地项目。

- 将引用对象复制到目标环境中的某些其他组合,并更新对其的引用。

通常,其指导是考虑复制到新环境中的对象引用的对象,并确保引用可在目标环境中解析。如果没有,采取适当的操作来修复引用,并使目标环境中有引用的对象可用。

2.3.4.2.4.2. 镜像 Registry 参考

镜像流指向镜像存储库,以指明它们所代表的镜像源。当镜像流从一个环境移到另一个环境时,务必要考虑 registry 和存储库引用是否还应更改:

- 如果使用不同的镜像 registry 来在测试环境和生产环境之间断言隔离。

- 如果使用不同的镜像存储库来分隔测试和生产就绪的镜像。

如果其中任何一个情况是,在从源环境复制到目标环境时,必须修改镜像流,以便其解析为正确的镜像。这还执行 Scenarios 和 Examples 中描述的步骤,将镜像从一个 registry 和 repository 复制到另一个。

2.3.4.3. 概述

此时定义了以下内容:

- 组成已部署应用程序的新应用程序工件。

- 将应用程序提升活动与 OpenShift Container Platform 提供的工具和概念关联。

- OpenShift Container Platform 和 CI/CD 管道引擎 Jenkins 之间的集成。

将应用程序提升流的示例放在 OpenShift Container Platform 中,是本主题的最后一步。

2.3.5. 场景和示例

在 Docker、Kubernetes 和 OpenShift Container Platform 生态系统中定义了新的应用程序工件组件,本节介绍了如何使用 OpenShift Container Platform 提供的机制和工具在环境之间提升这些组件。

镜像是组成应用程序的组件的主要工件。采用该内部环境并将其扩展至应用程序提升、核心、基本应用程序提升模式是映像提升,其中工作单元是镜像。大多数应用程序促销方案通过提升管道管理和传播镜像。

仅仅通过管道管理和传播镜像的简单场景。随着推广方案的范围广泛,其他应用程序工件(特别是 API 对象)都包含在通过管道进行管理和传播的项目清单中。

本主题介绍了一些有关使用手动和自动化方法来提升镜像以及 API 对象的特定示例。但请注意以下设置应用程序提升管道的环境。

2.3.5.1. 为提升设置

完成应用程序初始修订的开发后,下一步是打包应用程序的内容,以便您可以转移到提升管道的后续暂存环境。

首先,将您查看的所有 API 对象作为传输进行分组,并为它们应用通用

标签:labels: promotion-group: <application_name>

如前文所述,

oc label命令协助使用各种 API 对象管理标签。提示如果您最初在 OpenShift Container Platform 模板中定义 API 对象,您可以轻松确保所有相关对象在导出以准备提升时用于查询。

您可以在后续查询中使用该标签。例如,请考虑以下一组

oc命令调用,然后达到应用程序的 API 对象的传输:$ oc login <source_environment> $ oc project <source_project> $ oc export dc,is,svc,route,secret,sa -l promotion-group=<application_name> -o yaml > export.yaml $ oc login <target_environment> $ oc new-project <target_project> 1 $ oc create -f export.yaml- 1

- 或者,如果已存在则为

oc project <target_project>。

注意在

oc export命令中,无论您是否包含镜像流的是类型,您都可以选择如何管理管道中不同环境的镜像、镜像流和模板。下文将讨论有关此问题的注意事项。另请参阅 管理镜像 主题。您还必须获取针对提升管道中不同暂存环境中使用的每个 registry 操作所需的令牌。对于每个环境:

登录到环境:

$ oc login <each_environment_with_a_unique_registry>

使用以下命令获取访问令牌:

$ oc whoami -t

- 复制并粘贴令牌值供以后使用。

2.3.5.2. 可重复提升流程

在为您的管道进行另一个暂存环境的初始设置后,通过提升管道验证应用程序的每个迭代可以启动一组可重复的步骤。每次源环境中的镜像或 API 对象改变时会执行这些基本步骤:

移动更新的镜像 → Move updated API 对象 → Apply 环境特定自定义

通常,第一步是将与应用程序关联的镜像的任何更新提升到管道中的下一阶段。如上面所述,提升镜像的关键差异化是 OpenShift Container Platform registry 是否在暂存环境间共享。

如果 registry 共享,则只利用

oc tag:$ oc tag <project_for_stage_N>/<imagestream_name_for_stage_N>:<tag_for_stage_N> <project_for_stage_N+1>/<imagestream_name_for_stage_N+1>:<tag_for_stage_N+1>

如果没有共享 registry,您可以在登录到源和目标 registry 时为每个提升管道 registry 使用访问令牌,相应地拉取、标记和推送应用程序镜像:

登录到源环境 registry:

$ docker login -u <username> -e <any_email_address> -p <token_value> <src_env_registry_ip>:<port>

拉取应用程序的镜像:

$ docker pull <src_env_registry_ip>:<port>/<namespace>/<image name>:<tag>

将应用程序的镜像标记到目标 registry 的位置,根据需要更新命名空间、名称和标签,以符合目标暂存环境:

$ docker tag <src_env_registry_ip>:<port>/<namespace>/<image name>:<tag> <dest_env_registry_ip>:<port>/<namespace>/<image name>:<tag>

登录到目标暂存环境 registry:

$ docker login -u <username> -e <any_email_address> -p <token_value> <dest_env_registry_ip>:<port>

将镜像推送到其目的地:

$ docker push <dest_env_registry_ip>:<port>/<namespace>/<image name>:<tag>

提示要从外部 registry 自动导入镜像的新版本,

oc tag命令有一个--scheduled选项。如果使用,则ImageStreamTag引用的镜像将定期从托管镜像的 registry 中拉取。

接下来,在有些情况下,应用程序的发展需要对您的 API 对象进行基本更改,或者从组成应用程序的 API 对象集合中移除。当应用程序 API 对象出现这种演变时,OpenShift Container Platform CLI 提供了广泛的选项来从一个暂存环境转移到下一个阶段。

从最初设置提升管道时启动的方式相同:

$ oc login <source_environment> $ oc project <source_project> $ oc export dc,is,svc,route,secret,sa -l promotion-group=<application_name> -o yaml > export.yaml $ oc login <target_environment> $ oc <target_project>

更新它们,而不是简单地在新环境中创建资源。您可以按照几种不同的方式实现:

更保守的方法是使用

oc apply并合并对目标环境中每个 API 对象的新更改。要做到这一点,您可以在实际更改对象前--dry-run=true选项并检查生成的对象:$ oc apply -f export.yaml --dry-run=true

如果满意,则实际运行

apply命令:$ oc apply -f export.yaml

apply命令可以选择使用额外的参数,以帮助实现更复杂的场景。如需了解更多详细信息,请参阅oc apply --help。或者,更简单但更积极的方法是使用

oc replace。没有使用此更新且替换的空运行。在最基本的形式中,这涉及执行:$ oc replace -f export.yaml

与

apply一样,replace(可选)为更复杂的行为采用附加参数。如需了解更多详细信息,请参阅oc replace --help。

-

前面的步骤会自动处理引入的新 API 对象,但如果从源环境中删除 API 对象,必须使用

oc delete从目标环境中手动删除它们。 对于任何 API 对象而言,可能需要调整环境变量,因为这些对象所需的值可能会在暂存环境之间有所不同。为此,请使用

oc set env:$ oc set env <api_object_type>/<api_object_ID> <env_var_name>=<env_var_value>

-

最后,使用

oc rollout命令或上方 Deployments 部分中讨论的其他机制之一来触发更新的应用程序的新部署。

2.3.5.3. 使用 Jenkins 可重复提升过程

用于 OpenShift Container Platform 的 Jenkins Docker 镜像 中定义的 OpenShift Sample 作业是一个在 Jenkins 构造中 OpenShift Container Platform 中的镜像提升示例。本示例的设置位于 OpenShift Origin 源存储库中。

这个示例包括:

- 使用 Jenkins 作为 CI/CD 引擎。

-

将 OpenShift Pipeline 插件用于 Jenkins。此插件提供了

ocCLI 为打包为 Jenkins Freestyle 和 DSL 作业步骤的 oc CLI 提供的功能子集。请注意,oc二进制文件也包含在用于 OpenShift Container Platform 的 Jenkins Docker 镜像中,也可用于与 Jenkins 任务中的 OpenShift Container Platform 交互。 - OpenShift Container Platform 提供的 Jenkins 的模板。适用于临时存储和持久存储的模板。

-

示例应用 :在 OpenShift Origin 源存储库 中定义,此应用利用

ImageStreams、imageChangeTriggers、ImageStreamTags、BuildConfigs和与提升管道中不同阶段对应的DeploymentConfig和服务。

下面将更加详细地检查 OpenShift Sample 作业的各种部分:

-

第一步是 等同于

oc scale dc frontend --replicas=0调用。此步骤旨在关闭可能正在运行的应用程序镜像的任何早期版本。 -

第二个步骤 等同于

oc start-build frontend调用。 -

第三个步骤 等同于

oc rollout latest dc/frontend调用。 - 第四个步骤是本例的"测试"步骤。它确保此应用程序的相关服务实际上可从网络角度访问。在覆盖范围内,针对与 OpenShift Container Platform 服务关联的 IP 地址和端口尝试套接字连接。当然,可以添加额外的测试(如果没有通过 OpenShift Pipepline 插件步骤),然后通过使用 Jenkins Shell 步骤来利用操作系统级命令和脚本来测试应用程序。

-

第五个步骤开始假设测试通过的应用程序,因此希望将镜像标记为"就绪"。在这一步中,会从 latest 镜像为应用镜像创建一个新的 prod 标签。随着 frontend

DeploymentConfig有一个为该标签定义的ImageChangeTrigger,则会启动对应的"production"部署。 - 第六个和最后一个步骤 是一个验证步骤,插件确认 OpenShift Container Platform 为 "production" 部署启动了所需的副本数。

第 3 章 身份验证

3.1. Web 控制台身份验证

从位于 <master_public_addr>:8443 的浏览器访问 Web 控制台时,您会自动重定向到登录页面。

查看可用于访问 Web 控制台的 浏览器版本和操作系统。

您可以在此页面中提供您的登录凭证,以获取令牌来发出 API 调用。登录后,您可以使用 Web 控制台 导航到项目。

3.2. CLI 身份验证

您可以在命令行中使用 CLI 命令 oc login 进行身份验证。您可以在没有选项的情况下运行这个命令来 开始使用 CLI :

$ oc login

命令的交互式流可帮助您使用提供的凭证建立到 OpenShift Container Platform 服务器的会话。如果没有提供成功登录到 OpenShift Container Platform 服务器所需的信息,命令会根据需要提示用户输入。配置会自动保存,然后用于后续命令。

oc login --help 中列出的 oc login 命令的所有配置选项都是可选的。以下示例显示一些常见选项的使用:

$ oc login [-u=<username>] \ [-p=<password>] \ [-s=<server>] \ [-n=<project>] \ [--certificate-authority=</path/to/file.crt>|--insecure-skip-tls-verify]

下表描述了这些通用选项:

表 3.1. 常见 CLI 配置选项

| 选项 | 语法 | 描述 |

|---|---|---|

|

|

$ oc login -s=<server> | 指定 OpenShift Container Platform 服务器的主机名。如果通过此标志提供服务器,命令不会以交互方式询问服务器。如果您已有 CLI 配置文件并希望登录并切换到其他服务器,也可以使用此标志。 |

|

|

$ oc login -u=<username> -p=<password> | 允许您指定凭证登录 OpenShift Container Platform 服务器。如果通过这些标志提供用户名和密码,命令不会以互动方式询问。如果您已建立会话令牌的配置文件并希望登录并切换到另一个用户名,也可以使用这些标志。 |

|

|

$ oc login -u=<username> -p=<password> -n=<project> |

一个全局 CLI 选项,它用于 |

|

|

$ oc login --certificate-authority=<path/to/file.crt> | 使用 HTTPS 的 OpenShift Container Platform 服务器正确且安全地进行身份验证。必须提供证书颁发机构文件的路径。 |

|

|

$ oc login --insecure-skip-tls-verify |

允许与 HTTPS 服务器交互绕过服务器证书检查,但请注意,这不太安全。如果您尝试 |

通过 CLI 配置文件,您可以轻松管理多个 CLI 配置文件。

第 4 章 授权

4.1. 概述

本主题包含应用程序开发人员及其功能的授权任务,具体由集群管理员规定。

4.2. 检查用户是否可以创建 Pod

使用 scc-review 和 scc-subject-review 选项,您可以看到单个用户或特定服务帐户下的用户能否创建或更新 pod。

使用 scc-review 选项,您可以检查服务帐户是否可以创建或更新 pod。命令输出接受该资源的安全性上下文约束。

例如,要检查具有 system:serviceaccount:projectname:default 服务帐户的用户是否可以创建一个 pod:

$ oc policy scc-review -z system:serviceaccount:projectname:default -f my_resource.yaml

您还可以使用 scc-subject-review 选项检查特定用户是否可以创建或更新 pod:

$ oc policy scc-subject-review -u <username> -f my_resource.yaml

要检查属于特定组的用户是否可以在特定文件中创建 pod:

$ oc policy scc-subject-review -u <username> -g <groupname> -f my_resource.yaml

4.3. 确定您可以作为经过身份验证的用户执行什么操作

在 OpenShift Container Platform 项目中,您可以决定对所有命名空间范围的资源(包括第三方资源)执行的操作 verbs。

can-i 命令选项测试用户和角色方面的范围。

$ oc policy can-i --list --loglevel=8

输出可帮助您确定提出哪些 API 请求来收集信息。

要以用户可读格式接收信息,请运行:

$ oc policy can-i --list

输出提供了一个完整的列表。

要确定您可以执行特定的操作动词,请运行:

$ oc policy can-i <verb> <resource>

用户范围 可以提供有关给定范围的更多信息。例如:

$ oc policy can-i <verb> <resource> --scopes=user:info

第 5 章 项目

5.1. 概述

通过项目,一个社区的用户可以在与其他社区隔离的前提下组织和管理其内容。

5.2. 创建一个项目

如果集群管理员允许,您可以使用 CLI 或 Web 控制台 创建新项目。

5.2.1. 使用 Web 控制台

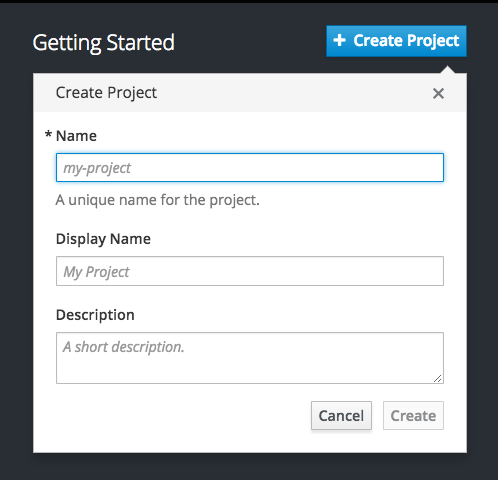

若要使用 Web 控制台创建新项目,请单击 Projects 面板或 Projects 页面上的 Create Project 按钮。

默认情况下会显示 Create Project 按钮,但可以选择进行隐藏或自定义。

5.2.2. 使用 CLI

使用 CLI 创建新项目:

$ oc new-project <project_name> \

--description="<description>" --display-name="<display_name>"例如:

$ oc new-project hello-openshift \

--description="This is an example project to demonstrate OpenShift v3" \

--display-name="Hello OpenShift"系统管理员可能会限制允许创建的项目数量。达到限制后,可能需要删除现有项目来创建新项目。

5.3. 查看项目

查看项目时,只能看到根据授权策略您有权访问的项目。

要查看项目列表,请运行:

$ oc get projects

您可以从当前项目更改到其他项目,以进行 CLI 操作。然后,所有操控项目范围内容的后续操作都会使用指定的项目:

$ oc project <project_name>

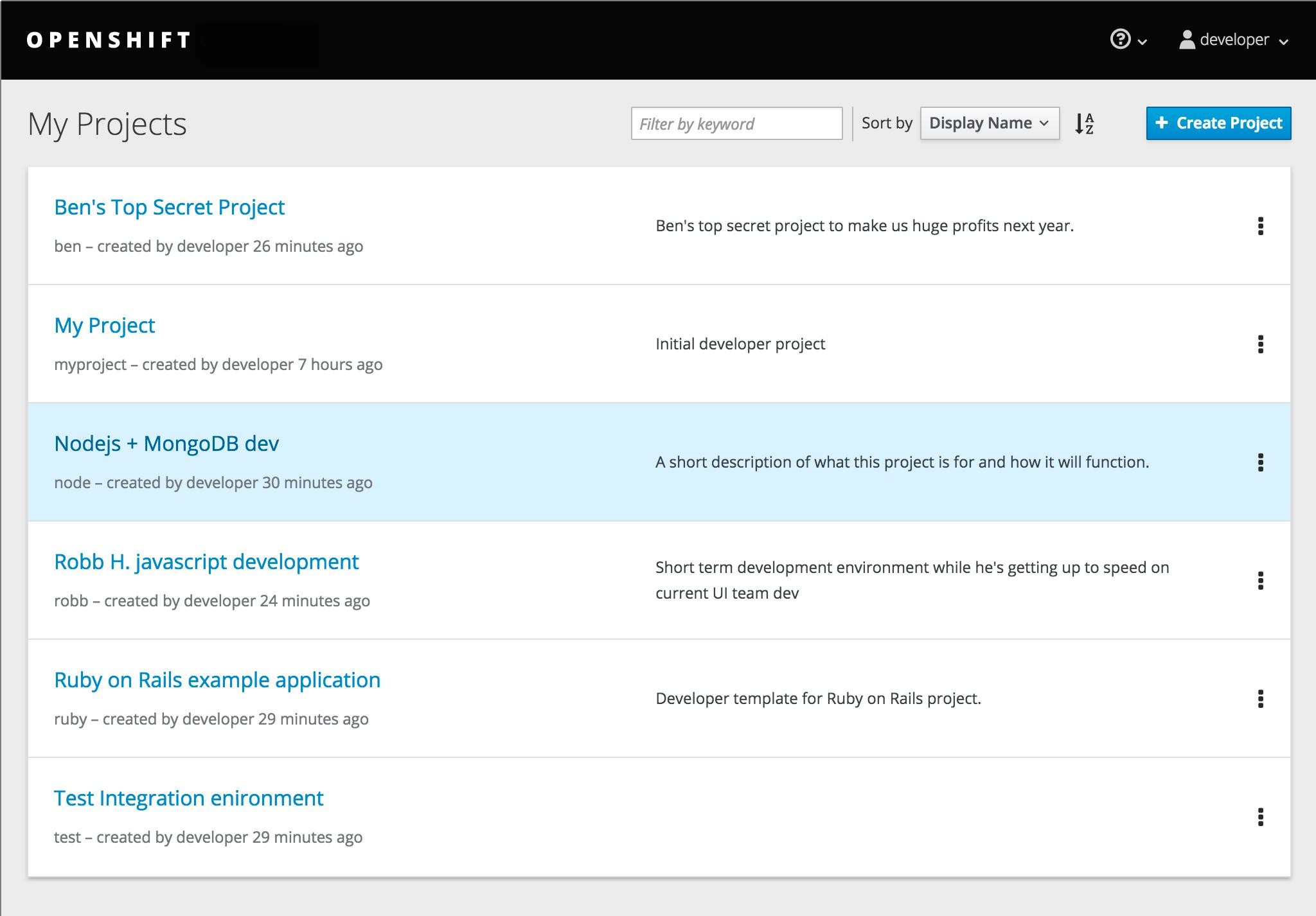

您还可以使用 Web 控制台在 项目之间查看和更改。身份验证并登录后,您会看到您有权访问的项目列表。

服务目录显示的右侧面板提供对最新访问的项目(最多五个项目)的快速访问。如需项目的完整列表,请使用右侧面板顶部的 View All 链接。

如果使用 CLI 创建新项目,您可以在浏览器中刷新页面以查看新项目。

选择一个项目可进入项目的项目概述。

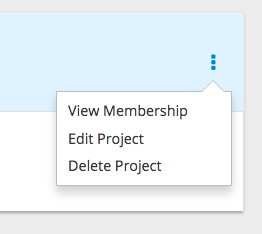

点击特定项目的 kebab 菜单来为您提供以下选项:

5.4. 检查项目状态

oc status 命令提供当前项目的高级概述,及其组件及其关系。这个命令没有参数:

$ oc status

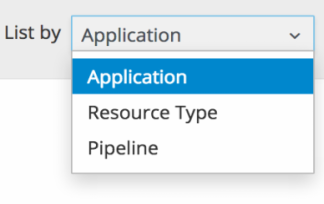

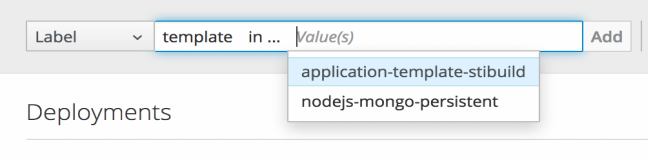

5.5. 按标签过滤

您可以使用资源标签过滤 Web 控制台中 的项目页面的内容。您可以从推荐的标签名称和值中选择,或者自行输入。可以添加多个过滤器。应用多个过滤器时,资源必须匹配所有过滤器才能保持可见。

按标签进行过滤:

选择标签类型:

任选以下一项:

exists

验证标签名称是否存在,但忽略其值。

does not exist

验证标签名称不存在,但忽略其值。

in

验证标签名称是否存在,并且等于所选值之一。

not in

验证标签名称不存在,或者不等于任何所选值。

如果选择 in 或 not in,选择一组值,然后选择 Filter:

添加过滤器后,您可以通过选择 Clear all 过滤器来停止过滤,或者点击单个过滤器来删除它们:

5.6. 书签页面状态

OpenShift Container Platform Web 控制台现在书签页状态,这有助于保存标签过滤器和其他设置。

当您执行更改页面的状态时,如在标签页间切换时,浏览器导航栏中的 URL 会被自动更新。

5.7. 删除项目

当您删除项目时,服务器会将项目状态从 Active 更新为 Terminating。然后,服务器会清除正在终止的项目中的所有内容,然后最终删除项目。在项目处于 Terminating 状态时,用户无法向项目添加新内容。可以从 CLI 或 Web 控制台删除项目。

使用 CLI 删除项目:

$ oc delete project <project_name>

第 6 章 迁移应用程序

6.1. 概述

本主题涵盖 OpenShift 版本 2(v2)应用迁移到 OpenShift 版本 3(v3)的迁移步骤。

本主题使用一些特定于 OpenShift v2 的术语。比较 OpenShift Enterprise 2 和 OpenShift Enterprise 3 可深入了解两个版本与所用的语言之间的差别。

要将 OpenShift v2 应用程序迁移到 OpenShift Container Platform v3,v2 应用程序中的所有cartridge 必须记录,因为每个 v2 cartridge 等同于 OpenShift Container Platform v3 中的相应镜像或模板,且必须单独迁移。对于每个 cartridge,还必须记录所有依赖项或所需软件包,因为它们必须包含在 v3 镜像中。

常规迁移步骤为:

备份 v2 应用。

- Web cartridge:可以将源代码备份到 Git 存储库,如推送到 GitHub 上的存储库。

-

数据库 cartridge:数据库可以使用转储命令(

mongodump、mysqldump、pg_dump)备份,以备份数据库。 Web 和数据库模块:

rhc客户端工具提供备份多个模块的快照功能:$ rhc snapshot save <app_name>

快照是可以解压缩的 tar 文件,其内容是应用源代码和数据库转储。

- 如果应用程序有数据库 cartridge,请创建一个 v3 数据库应用程序,将数据库转储同步到新 v3 数据库应用程序的 pod,然后使用数据库恢复命令恢复 v3 数据库应用程序中的 v2 数据库。

- 对于 Web 框架应用程序,编辑应用源代码,使其与 v3 兼容。然后,添加 Git 存储库中的相应文件中所需的任何依赖项或软件包。将 v2 环境变量转换为对应的 v3 环境变量。

- 从源(您的 Git 存储库)或者从带有 Git URL 的快速入门中创建 v3 应用程序。另外,将数据库服务参数添加到新应用,将数据库应用链接到 Web 应用。

- 在 v2 中,有一个集成的 Git 环境,应用程序会在更改推送到 v2 Git 存储库时自动重新构建和重启。在 v3 中,若要由推送到公共 Git 存储库的源代码更改自动触发构建,您必须在 v3 的初始构建完成后设置 webhook。

6.2. 迁移数据库应用程序

6.2.1. 概述

本节复习如何将 MySQL、PostgreSQL 和 MongoDB 数据库应用程序从 OpenShift 版本 2(v2)迁移到 OpenShift 版本 3(v3)。

6.2.2. 支持的数据库

| v2 | v3 |

|---|---|

| MongoDB: 2.4 | MongoDB: 2.4、2.6 |

| MySQL: 5.5 | MySQL: 5.5, 5.6 |

| PostgreSQL: 9.2 | PostgreSQL: 9.2, 9.4 |

6.2.3. MySQL

将所有数据库导出到转储文件并将其复制到本地计算机(位于当前目录中):

$ rhc ssh <v2_application_name> $ mysqldump --skip-lock-tables -h $OPENSHIFT_MYSQL_DB_HOST -P ${OPENSHIFT_MYSQL_DB_PORT:-3306} -u ${OPENSHIFT_MYSQL_DB_USERNAME:-'admin'} \ --password="$OPENSHIFT_MYSQL_DB_PASSWORD" --all-databases > ~/app-root/data/all.sql $ exit将 dbdump 下载到您的本地机器中:

$ mkdir mysqldumpdir $ rhc scp -a <v2_application_name> download mysqldumpdir app-root/data/all.sql

从模板创建 v3 mysql-persistent pod:

$ oc new-app mysql-persistent -p \ MYSQL_USER=<your_V2_mysql_username> -p \ MYSQL_PASSWORD=<your_v2_mysql_password> -p MYSQL_DATABASE=<your_v2_database_name>

检查 pod 是否准备就绪:

$ oc get pods

当 pod 上线并运行时,将数据库存档文件复制到您的 v3 MySQL pod 中:

$ oc rsync /local/mysqldumpdir <mysql_pod_name>:/var/lib/mysql/data

恢复运行 v3 的 pod 中的数据库:

$ oc rsh <mysql_pod> $ cd /var/lib/mysql/data/mysqldumpdir

在 v3 中,若要恢复您需要以 root 用户身份访问 MySQL 的数据库。

在 v2 中,

$OPENSHIFT_MYSQL_DB_USERNAME对所有数据库具有完整权限。在 v3 中,您必须为每个数据库授予$MYSQL_USER的权限。$ mysql -u root $ source all.sql

将 <dbname> 的所有权限授予

<your_v2_username>@localhost,然后清空权限。从 pod 中删除转储目录:

$ cd ../; rm -rf /var/lib/mysql/data/mysqldumpdir

支持的 MySQL 环境变量

| v2 | v3 |

|---|---|

|

|

|

|

|

|

|

|

|

|

|

|

|

| |

|

| |

|

| |

|

| |

|

| |

|

| |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

| |

|

| |

|

| |

|

| |

|

| |

|

|

6.2.4. PostgreSQL

从 gear 备份 v2 PostgreSQL 数据库:

$ rhc ssh -a <v2-application_name> $ mkdir ~/app-root/data/tmp $ pg_dump <database_name> | gzip > ~/app-root/data/tmp/<database_name>.gz

将备份文件提取到本地机器:

$ rhc scp -a <v2_application_name> download <local_dest> app-root/data/tmp/<db-name>.gz $ gzip -d <database-name>.gz

注意将备份文件保存到单独的文件夹,以供第 4 步使用。

使用 v2 应用程序数据库名称、用户名和密码来创建 PostgreSQL 服务,以创建新服务:

$ oc new-app postgresql-persistent -p POSTGRESQL_DATABASE=dbname -p POSTGRESQL_PASSWORD=password -p POSTGRESQL_USER=username

检查 pod 是否准备就绪:

$ oc get pods

当 pod 上线并运行时,将备份目录同步到 pod:

$ oc rsync /local/path/to/dir <postgresql_pod_name>:/var/lib/pgsql/data

远程访问 pod:

$ oc rsh <pod_name>

恢复数据库:

psql dbname < /var/lib/pgsql/data/<database_backup_file>

删除不再需要的所有备份文件:

$ rm /var/lib/pgsql/data/<database-backup-file>

支持的 PostgreSQL 环境变量

| v2 | v3 |

|---|---|

|

|

|

|

|

|

|

|

|

|

|

|

|

| |

|

| |

|

| |

|

| |

|

| |

|

| |

|

| |

|

| |

|

| |

|

| |

|

| |

|

| |

|

| |

|

|

6.2.5. MongoDB

- 对于 OpenShift v3: MongoDB shell 版本 3.2.6

- 对于 OpenShift v2: MongoDB shell 版本 2.4.9

通过

ssh命令远程访问 v2 应用程序:$ rhc ssh <v2_application_name>

运行 mongodump,使用

-d <database_name> -c <collections>指定单个数据库。如果没有这些选项,转储所有数据库。每个数据库在其自己的目录中转储:$ mongodump -h $OPENSHIFT_MONGODB_DB_HOST -o app-root/repo/mydbdump -u 'admin' -p $OPENSHIFT_MONGODB_DB_PASSWORD $ cd app-root/repo/mydbdump/<database_name>; tar -cvzf dbname.tar.gz $ exit

将 dbdump 下载到 mongodump 目录中的本地机器:

$ mkdir mongodump $ rhc scp -a <v2 appname> download mongodump \ app-root/repo/mydbdump/<dbname>/dbname.tar.gz

在 v3 中启动 MongoDB pod。由于最新的镜像(3.2.6)不包括 mongo-tools,若要使用

mongorestore或mongoimport命令,您需要编辑默认的 mongodb-persistent 模板,以指定包含mongo-tools, “mongodb:2.4”的镜像标签。因此,需要以下oc export命令和编辑:$ oc export template mongodb-persistent -n openshift -o json > mongodb-24persistent.json

编辑 mongodb-24persistent.json 的第 80 行;将

mongodb:latest替换为mongodb:2.4。$ oc new-app --template=mongodb-persistent -n <project-name-that-template-was-created-in> \ MONGODB_USER=user_from_v2_app -p \ MONGODB_PASSWORD=password_from_v2_db -p \ MONGODB_DATABASE=v2_dbname -p \ MONGODB_ADMIN_PASSWORD=password_from_v2_db $ oc get pods

当 mongodb pod 上线并运行时,将数据库存档文件复制到 v3 MongoDB pod 中:

$ oc rsync local/path/to/mongodump <mongodb_pod_name>:/var/lib/mongodb/data $ oc rsh <mongodb_pod>

在 MongoDB pod 中,为您要恢复的每个数据库完成以下内容:

$ cd /var/lib/mongodb/data/mongodump $ tar -xzvf dbname.tar.gz $ mongorestore -u $MONGODB_USER -p $MONGODB_PASSWORD -d dbname -v /var/lib/mongodb/data/mongodump

检查数据库是否已恢复:

$ mongo admin -u $MONGODB_USER -p $MONGODB_ADMIN_PASSWORD $ use dbname $ show collections $ exit

从 pod 中删除 mongodump 目录:

$ rm -rf /var/lib/mongodb/data/mongodump

支持的 MongoDB 环境变量

| v2 | v3 |

|---|---|

|

|

|

|

|

|

|

|

|

|

|

|

|

| |

|

| |

|

| |

|

| |

|

| |

|

| |

|

| |

|

| |

|

|

6.3. 迁移 Web 框架应用程序

6.3.1. 概述

本主题介绍了如何将 Python、Ruby、PHP、Perl、Node.js、WordPress、Ghost、JBoss EAP、JBoss WS(Tomcat)和 Wildfly 10(JBoss AS)Web 框架应用程序从 OpenShift 版本 2(v2)迁移到 OpenShift 版本 3(v3)。

6.3.2. Python

设置新的 GitHub 存储库,并将它作为远程分支添加到当前本地 v2 Git 存储库中:

$ git remote add <remote-name> https://github.com/<github-id>/<repo-name>.git

将本地 v2 源代码推送到新存储库:

$ git push -u <remote-name> master

确保所有重要文件(如 setup.py、wsgi.py、requirements.txt etc)都应推送到新存储库。

- 确定您的应用程序所需的所有软件包都包含在 requirements.txt 中。

使用

oc命令从构建器镜像和源代码中启动新的 Python 应用程序:$ oc new-app --strategy=source python:3.3~https://github.com/<github-id>/<repo-name> --name=<app-name> -e <ENV_VAR_NAME>=<env_var_value>

支持的 Python 版本

| v2 | v3 |

|---|---|

| Python: 2.6、2.7、3.3 | |

| Django | Django-psql-example(快速入门) |

6.3.3. Ruby

设置新的 GitHub 存储库,并将它作为远程分支添加到当前本地 v2 Git 存储库中:

$ git remote add <remote-name> https://github.com/<github-id>/<repo-name>.git

将本地 v2 源代码推送到新存储库:

$ git push -u <remote-name> master

如果您没有 Gemfile 并运行一个简单的机架应用程序,请将这个 Gemfile 复制到您的源的根目录中:

https://github.com/sclorg/ruby-ex/blob/master/Gemfile

注意支持 Ruby 2.0 的 rack gem 的最新版本是 1.6.4,因此需要将 Gemfile 修改为

gem 'rack', “1.6.4”。对于 Ruby 2.2 或更高版本,使用 rack gem 2.0 或更高版本。

使用

oc命令从构建器镜像和源代码中启动新的 Ruby 应用程序:$ oc new-app --strategy=source ruby:2.0~https://github.com/<github-id>/<repo-name>.git

支持的 Ruby 版本

| v2 | v3 |

|---|---|

| ruby: 1.8, 1.9, 2.0 | |

| Ruby on Rails: 3, 4 | Rails-postgresql-example(快速入门) |

| Sinatra |

6.3.4. PHP

设置新的 GitHub 存储库,并将它作为远程分支添加到当前本地 v2 Git 存储库中:

$ git remote add <remote-name> https://github.com/<github-id>/<repo-name>

将本地 v2 源代码推送到新存储库:

$ git push -u <remote-name> master

使用

oc命令从构建器镜像和源代码中启动新的 PHP 应用程序:$ oc new-app https://github.com/<github-id>/<repo-name>.git --name=<app-name> -e <ENV_VAR_NAME>=<env_var_value>

支持的 PHP 版本

| v2 | v3 |

|---|---|

| PHP: 5.3, 5.4 | |

| 带有 Zend Server 6.1 的 PHP 5.4 | |

| CodeIgniter 2 | |

| HHVM | |

| Laravel 5.0 | |

| cakephp-mysql-example (quickstart) |

6.3.5. Perl

设置新的 GitHub 存储库,并将它作为远程分支添加到当前本地 v2 Git 存储库中:

$ git remote add <remote-name> https://github.com/<github-id>/<repo-name>

将本地 v2 源代码推送到新存储库:

$ git push -u <remote-name> master

编辑本地 Git 存储库并推送上游更改,使其与 v3 兼容:

在 v2 中,CPAN 模块驻留在 .openshift/cpan.txt 中。在 v3 中,s2i 构建器在源的根目录中查找名为 cpanfile 的文件。

$ cd <local-git-repository> $ mv .openshift/cpan.txt cpanfile

编辑 cpanfile,因为它的格式略有不同:

cpanfile 格式 cpan.txt 格式 需要 'cpan::mod';

cpan::mod

需要"Dancer";

Dancer

需要 'YAML';

YAML

删除 .openshift 目录

注意在 v3 中,action_hooks 和 cron 任务的支持方式不同。如需更多信息,请参阅 Action Hook。

-

使用

oc命令从构建器镜像和源代码中启动新的 Perl 应用程序:

$ oc new-app https://github.com/<github-id>/<repo-name>.git

支持的 Perl 版本

| v2 | v3 |

|---|---|

| Perl: 5.10 | |

| dancer-mysql-example(Quickstart) |

6.3.6. Node.js

设置新的 GitHub 存储库,并将它作为远程分支添加到当前本地 Git 存储库:

$ git remote add <remote-name> https://github.com/<github-id>/<repo-name>

将本地 v2 源代码推送到新存储库:

$ git push -u <remote-name> master

编辑本地 Git 存储库并推送上游更改,使其与 v3 兼容:

删除 .openshift 目录。

注意在 v3 中,action_hooks 和 cron 任务的支持方式不同。如需更多信息,请参阅 Action Hook。

编辑 server.js。

- L116 server.js: 'self.app = express();'

- L25 server.js: self.ipaddress = '0.0.0.0';

L26 server.js: self.port = 8080;

注意行(L)来自基础 V2 cartridge server.js。

使用

oc命令从构建器镜像和源代码中启动新的 Node.js 应用程序:$ oc new-app https://github.com/<github-id>/<repo-name>.git --name=<app-name> -e <ENV_VAR_NAME>=<env_var_value>

支持的 Node.js 版本

| v2 | v3 |

|---|---|

| Node.js 0.10 | |

| nodejs-mongodb-example。此快速入门模板只支持 Node.js 版本 6。 |

6.3.7. WordPress

目前,迁移 WordPress 应用程序的支持仅由社区提供,而不受红帽支持提供。

有关将 WordPress 应用程序迁移到 OpenShift Container Platform v3 的指南,请参阅 OpenShift 博客。

6.3.8. Ghost

目前,对迁移 Ghost 应用程序的支持仅由社区提供,而不受红帽支持。

有关将 Ghost 应用程序迁移到 OpenShift Container Platform v3 的指导,请参阅 OpenShift 博客。

6.3.9. JBoss EAP

设置新的 GitHub 存储库,并将它作为远程分支添加到当前本地 Git 存储库:

$ git remote add <remote-name> https://github.com/<github-id>/<repo-name>

将本地 v2 源代码推送到新存储库:

$ git push -u <remote-name> master

- 如果存储库包含预构建的 .war 文件,它们需要驻留在存储库的根目录的 deployments 目录中。

使用 JBoss EAP 7 构建器镜像(jboss-eap70-openshift)和来自 GitHub 的源代码存储库创建新应用:

$ oc new-app --strategy=source jboss-eap70-openshift:1.6~https://github.com/<github-id>/<repo-name>.git

6.3.10. JBoss WS(Tomcat)

设置新的 GitHub 存储库,并将它作为远程分支添加到当前本地 Git 存储库:

$ git remote add <remote-name> https://github.com/<github-id>/<repo-name>

将本地 v2 源代码推送到新存储库:

$ git push -u <remote-name> master

- 如果存储库包含预构建的 .war 文件,它们需要驻留在存储库的根目录的 deployments 目录中。

使用 JBoss Web 服务器 3(Tomcat 7)构建器镜像(jboss-webserver30-tomcat7)和来自 GitHub 的源代码存储库创建新应用程序:

$ oc new-app --strategy=source jboss-webserver30-tomcat7-openshift~https://github.com/<github-id>/<repo-name>.git --name=<app-name> -e <ENV_VAR_NAME>=<env_var_value>

6.3.11. JBoss AS (Wildfly 10)

设置新的 GitHub 存储库,并将它作为远程分支添加到当前本地 Git 存储库:

$ git remote add <remote-name> https://github.com/<github-id>/<repo-name>

将本地 v2 源代码推送到新存储库:

$ git push -u <remote-name> master

编辑本地 Git 存储库并推送上游更改,使其与 v3 兼容:

删除 .openshift 目录。

注意在 v3 中,action_hooks 和 cron 任务的支持方式不同。如需更多信息,请参阅 Action Hook。

- 将 deployments 目录添加到源存储库的根目录中。将 .war 文件移到 'deployments' 目录。

使用

oc命令从构建器镜像和源代码中启动新的 Wildfly 应用程序:$ oc new-app https://github.com/<github-id>/<repo-name>.git --image-stream=”openshift/wildfly:10.0" --name=<app-name> -e <ENV_VAR_NAME>=<env_var_value>

注意参数

--name是可选的,用于指定应用程序的名称。参数-e是可选的,可添加构建和部署流程所需的环境变量,如OPENSHIFT_PYTHON_DIR。

6.3.12. 支持的 JBoss 版本

| v2 | v3 |

|---|---|

| JBoss App Server 7 | |

| Tomcat 6(JBoss EWS 1.0) | |

| Tomcat 7(JBoss EWS 2.0) | |

| Vert.x 2.1 | |

| WildFly App Server 10 | |

| WildFly App Server 8.2.1.Final | |

| WildFly App Server 9 | |

| CapeDwarf | |

| JBoss Data Virtualization 6 | |

| JBoss Enterprise App Platform(EAP)6 | |

| JBoss Unified Push Server 1.0.0.Beta1, Beta2 | |

| JBoss BPM 套件 | |

| JBoss BRMS | |

| jboss-eap70-openshift: 1.3-Beta | |

| eap64-https-s2i | |

| eap64-mongodb-persistent-s2i | |

| eap64-mysql-persistent-s2i | |

| eap64-psql-persistent-s2i |

6.4. Quickstart 示例

6.4.1. 概述

虽然 v2 quickstart to v3 Quickstart 没有清晰的迁移路径,但 v3 当前有以下快速入门。如果您的应用程序带有数据库,而不是使用 oc new-app 创建应用程序,则 oc new-app 会再次启动一个单独的数据库服务并使用通用环境变量将这两个应用程序链接到一起,您可以使用以下方法一次性从包含您的源代码的 GitHub 存储库中实例化链接的应用程序和数据库。您可以使用 oc get templates -n openshift 列出所有可用模板:

CakePHP MySQL https://github.com/sclorg/cakephp-ex

- template: cakephp-mysql-example

Node.js MongoDB https://github.com/sclorg/nodejs-ex

- template: nodejs-mongodb-example

Django PosgreSQL https://github.com/sclorg/django-ex

- template: django-psql-example

Dancer MySQL https://github.com/sclorg/dancer-ex

- template: dancer-mysql-example

Rails PostgreSQL https://github.com/sclorg/rails-ex

- template: rails-postgresql-example

6.4.2. 工作流

本地运行上述模板 URL 的 git clone。添加并提交应用程序源代码并推送 GitHub 存储库,然后从上面列出的其中一个模板启动 v3 Quickstart 应用程序:

- 为您的应用程序创建 GitHub 存储库。

克隆快速入门模板,并将 GitHub 存储库添加为远程:

$ git clone <one-of-the-template-URLs-listed-above> $ cd <your local git repository> $ git remote add upstream <https://github.com/<git-id>/<quickstart-repo>.git> $ git push -u upstream master

将您的源代码提交并推送到 GitHub:

$ cd <your local repository> $ git commit -am “added code for my app” $ git push origin master

在 v3 中创建一个新应用程序:

$ oc new-app --template=<template> \ -p SOURCE_REPOSITORY_URL=<https://github.com/<git-id>/<quickstart_repo>.git> \ -p DATABASE_USER=<your_db_user> \ -p DATABASE_NAME=<your_db_name> \ -p DATABASE_PASSWORD=<your_db_password> \ -p DATABASE_ADMIN_PASSWORD=<your_db_admin_password> 1- 1

- 仅适用于 MongoDB。

您现在应该有 2 个 pod 运行、Web 框架 Pod 和数据库 Pod。Web 框架 pod 环境应当与数据库 pod 环境匹配。您可以使用

oc set env pod/<pod_name> --list列出环境变量:-

DATABASE_NAME现在为<DB_SERVICE>_DATABASE -

DATABASE_USER现在是<DB_SERVICE>_USER -

DATABASE_PASSWORD现在为<DB_SERVICE>_PASSWORD DATABASE_ADMIN_PASSWORD现在是MONGODB_ADMIN_PASSWORD(仅适用于 MongoDB)如果没有指定

SOURCE_REPOSITORY_URL,该模板将使用上面列出的模板 URL(https://github.com/openshift/<quickstart>-ex)作为源存储库,并且将 hello-welcome 应用启动。

-

如果您要迁移数据库,请将数据库导出到转储文件,并在新的 v3 数据库 pod 中恢复数据库。请参阅 Database Applications 中介绍的步骤,跳过

oc new-app步骤,因为数据库 pod 已启动并在运行。

6.5. 持续集成和部署(CI/CD)

6.5.1. 概述

本节回顾 OpenShift 版本 2(v2)和 OpenShift 版本 3(v3)之间的持续集成和部署(CI/CD)应用的不同,以及如何将这些应用程序迁移到 v3 环境中。

6.5.2. Jenkins

OpenShift 版本 2(v2)和 OpenShift 版本 3(v3)中的 Jenkins 应用会因为架构中的基本差异而进行不同的配置。例如,在 v2 中,应用程序使用托管在 gear 中的集成 Git 存储库来存储源代码。在 v3 中,源代码位于托管在 pod 之外的公共或私有 Git 存储库中。

另外,在 OpenShift v3 中,Jenkins 作业只能被源代码更改触发,还由 ImageStream 中的更改,后者会更改用于构建应用的镜像及其源代码。因此,强烈建议您通过在 v3 中创建新的 Jenkins 应用来手动迁移 Jenkins 应用,然后使用适合 OpenShift v3 环境的配置重新创建作业。

请参考这些资源以了解有关如何创建 Jenkins 应用程序、配置作业和正确使用 Jenkins 插件的更多信息:

6.6. Webhook 和 Action Hook

6.6.1. 概述

本节回顾 OpenShift 版本 2(v2)和 OpenShift 版本 3(v3)之间的 webhook 和操作 hook,以及如何将这些应用迁移到 v3 环境中。

6.6.2. Webhook

从 GitHub 存储库创建

BuildConfig后,请运行:$ oc describe bc/<name-of-your-BuildConfig>

这将输出一个 Webhook GitHub URL,如下所示:

<https://api.starter-us-east-1.openshift.com:443/oapi/v1/namespaces/nsname/buildconfigs/bcname/webhooks/secret/github>.

- 从 GitHub Web 控制台将此 URL 剪切并粘贴到 GitHub 中。

- 在 GitHub 存储库中,从 Settings → Webhooks & Services 中选择 Add Webhook。

- 将 URL 输出(与上方相似)粘贴到 Payload URL 字段。

-

将 Content Type 设置为

application/json。 - 点击 Add webhook。

您应该看到一条来自 GitHub 的消息,说明您的 Webhook 已配置成功。

现在,每当您将更改推送到 GitHub 存储库时,新构建会自动启动,成功构建后也会启动新部署。

如果删除或重新创建应用程序,您必须使用新的 BuildConfig webhook url 更新 GitHub 中的 Payload URL 字段。

6.6.3. 操作 Hook

在 OpenShift 版本 2(v2)中,有构建、部署、post_deploy 和 pre_build 脚本或 action_hooks 位于 .openshift/action_hooks 目录中。虽然 v3 中没有适用于这些功能的一个一对一映射,但 v3 中的 S2I 工具有添加可自定义脚本的选项,在指定的 URL 或您的源存储库的 .s2i/bin 目录中。

OpenShift 版本 3(v3)还提供 post-build hook,用于运行镜像构建后镜像的基本测试,然后再推送到 registry。部署 hook 在部署配置中配置。

在 v2 中,action_hooks 通常用于设置环境变量。在 v2 中,任何环境变量都应该传递:

$ oc new-app <source-url> -e ENV_VAR=env_var

或:

$ oc new-app <template-name> -p ENV_VAR=env_var

另外,也可使用以下方法添加或更改环境变量:

$ oc set env dc/<name-of-dc> ENV_VAR1=env_var1 ENV_VAR2=env_var2’

6.7. S2I 工具

6.7.1. 概述

Source-to-Image(S2I)工具将应用源代码注入到容器镜像中,最终产品是一个新的、可直接运行的容器镜像,它融合了构建器镜像和构建的源代码。S2I 工具可以安装到本地机器上,而没有来自存储库的 OpenShift Container Platform。

S2I 工具是一个非常强大的工具,用于在 OpenShift Container Platform 上使用应用程序之前在本地测试和验证应用程序和镜像。

6.7.2. 创建容器镜像

- 识别应用所需的构建器镜像。红帽为不同的语言提供多个构建器镜像,包括 Python、Ruby、Perl、PHP 和 Node.js。其他镜像可从社区空间获取。

S2I 可以从本地文件系统中的源代码或从 Git 存储库构建镜像。从构建器镜像和源代码构建新容器镜像:

$ s2i build <source-location> <builder-image-name> <output-image-name>

注意<source-location>可以是 Git 存储库 URL,也可以是本地文件系统中源代码的目录。使用 Docker 守护进程测试构建的镜像:

$ docker run -d --name <new-name> -p <port-number>:<port-number> <output-image-name> $ curl localhost:<port-number>

- 将新镜像推送到 OpenShift registry。

使用

oc命令从 OpenShift registry 中的镜像创建新应用程序:$ oc new-app <image-name>

6.8. 支持指南

6.8.1. 概述

本主题回顾了 OpenShift 版本 2(v2)和 OpenShift 版本 3(v3)支持的语言、框架、数据库和标记。

如需有关 OpenShift Container Platform 客户使用的通用组合的更多信息,请参阅 OpenShift Container Platform 测试的集成。

6.8.2. 支持的数据库

请参阅 Database Applications 的支持的 Databases 部分。

6.8.3. 支持的语言

6.8.4. 支持的框架

表 6.1. 支持的框架

| v2 | v3 |

|---|---|

| Jenkins 服务器 | jenkins-persistent |

| Drupal 7 | |

| Ghost 0.7.5 | |

| WordPress 4 | |

| Ceylon | |

| Go | |

| MEAN |

6.8.5. 支持的标记

表 6.2. Python

| v2 | v3 |

|---|---|

| pip_install | 如果您的存储库包含 requirements.txt,则默认调用 pip。否则,不使用 pip。 |

表 6.3. Ruby

| v2 | v3 |

|---|---|

| disable_asset_compilation |

这可以通过在 buildconfig 策略定义中将 |

表 6.4. Perl

| v2 | v3 |

|---|---|

| enable_cpan_tests |

这可以通过在构建配置中将 |

表 6.5. PHP

| v2 | v3 |

|---|---|

| use_composer | 如果源存储库在根目录中包含 composer.json,则始终使用 Composer。 |

表 6.6. Node.js

| v2 | v3 |

|---|---|

| NODEJS_VERSION | N/A |

| use_npm |

npm 总是用于启动应用程序,除非将 |

表 6.7. JBoss EAP, JBoss WS, WildFly

| v2 | v3 |

|---|---|

| enable_debugging |

这个选项通过设置部署配置上设置的 |

| skip_maven_build | 如果存在 pom.xml,则会运行 maven。 |

| java7 | N/A |

| java8 | JavaEE 使用 JDK8。 |

表 6.8. Jenkins

| v2 | v3 |

|---|---|

| enable_debugging | N/A |

6.8.6. 支持的环境变量

第 7 章 教程

7.1. 概述

本节组包含如何在 OpenShift Container Platform 中启动并运行应用程序的信息,涵盖了不同的语言及其框架。

7.2. Quickstart 模板

7.2.1. 概述

快速入门是 OpenShift Container Platform 上运行的应用程序的基本示例。Quickstarts 提供多种语言和框架,并在模板中定义,模板由一组服务、构建配置和部署配置组成。该模板引用了构建和部署应用程序所需的镜像和源存储库。

要探索快速入门,请从模板创建应用程序。您的管理员可能已在您的 OpenShift Container Platform 集群中安装了这些模板,在这种情况下,您只需从 web 控制台中选择即可。有关如何上传、从中创建和修改 模板 的更多信息,请参阅模板文档。

Quickstarts 是指包含应用程序源代码的源存储库。要自定义 Quickstart,请分叉存储库,并在从模板创建应用程序时,用分叉的存储库替换默认的源存储库名称。这将导致使用您的源代码而非所提供的示例源来执行构建。然后,您可以更新源存储库中的代码,并启动新的构建来查看反映在所部署的应用程序中的更改。

7.2.2. Web 框架 Quickstart 模板

这些快速入门提供了指定框架和语言的基本应用程序:

7.3. Ruby on Rails

7.3.1. 概述

Ruby on Rails 是使用 Ruby 编写的流行 web 框架。本指南介绍在 OpenShift Container Platform 上使用 Rails 4。

我们强烈建议您完成整个教程,以概述在 OpenShift Container Platform 上运行应用程序所需的所有步骤。如果遇到问题,请尝试通读整个教程,然后再回看问题。该教程还可用于审查您之前采取的步骤,以确保正确执行了所有步骤。

对于本指南,您需要:

- 基本 Ruby/Rails 知识

- 本地安装的 Ruby 2.0.0+ 版本、Rubygems、Bundler

- 基本的 Git 知识

- 运行 OpenShift Container Platform v3 实例

7.3.2. 本地工作站设置

首先,确保 OpenShift Container Platform 实例正在运行且可用。有关如何启动并运行 OpenShift Container Platform 的更多信息,请检查 安装方法。另外,确保已安装 oc CLI 客户端,且可从命令 shell 访问命令,因此您可以使用您的电子邮件地址和密码使用它来 登录。

7.3.2.1. 设置数据库

Rails 应用程序几乎总是与数据库一同使用。对于本地开发,我们选择 PostgreSQL 数据库。要安装:

$ sudo yum install -y postgresql postgresql-server postgresql-devel

接下来,您需要使用以下方法初始化数据库:

$ sudo postgresql-setup initdb

该命令将创建 /var/lib/pgsql/data 目录,数据将存储在其中。

通过键入以下内容启动数据库:

$ sudo systemctl start postgresql.service

数据库运行时,创建 rails 用户:

$ sudo -u postgres createuser -s rails

请注意,我们创建的用户没有密码。

7.3.3. 编写应用程序

如果您要从头开始启动 Rails 应用程序,则需要首先安装 Rails gem。

$ gem install rails Successfully installed rails-4.2.0 1 gem installed

安装完 Rails gem 后,使用 PostgreSQL 创建一个新应用程序,作为数据库:

$ rails new rails-app --database=postgresql

然后,更改到您的新应用目录。

$ cd rails-app

如果您已有应用程序,请确保 Gemfile 中存在 pg (postgresql) gem。如果没有通过添加 gem 来编辑 Gemfile :

gem 'pg'

使用您的所有依赖项生成一个新的 Gemfile.lock :

$ bundle install

除了将 postgresql 数据库与 pg gem 结合使用外,还需要确保 config/database.yml 正在使用 postgresql 适配器。

请确保更新了 config/database.yml 文件中的 default 部分,如下所示:

default: &default adapter: postgresql encoding: unicode pool: 5 host: localhost username: rails password:

使用此 rake 命令创建应用程序的开发和测试数据库:

$ rake db:create

这将在您的 PostgreSQL 服务器中创建 development 和 test 数据库。

7.3.3.1. 创建欢迎页面

由于 Rails 4 在生产中不再提供静态 public/index.html 页面,因此我们需要创建一个新的 root 页面。

要具有自定义欢迎页面,需要执行以下步骤:

- 使用索引操作创建 controller

-

为

welcome控制器index操作创建 view 页面 - 使用所创建的 controller 和 view 创建一个提供应用程序 root 页面的 route

Rails 提供了一个生成器,可为您执行所有必要的步骤。

$ rails generate controller welcome index

现在,已创建所有必需的文件,现在只需要在 config/routes.rb 文件中编辑行 2,如下所示:

root 'welcome#index'

运行 rails 服务器以验证页面是否可用。

$ rails server

在浏览器中访问 http://localhost:3000 即可查看您的页面。如果没有看到该页面,请检查输出至服务器的日志进行调试。

7.3.3.2. 为 OpenShift Container Platform 配置应用程序

要让您的应用程序与将在 OpenShift Container Platform 中运行的 PostgreSQL 数据库服务通信,您需要编辑 config/database.yml 中的 default 部分,以便在创建数据库服务时使用环境变量。

您编辑的 config/database.yml 中的 default 部分和预定义的变量应类似于如下:

<% user = ENV.key?("POSTGRESQL_ADMIN_PASSWORD") ? "root" : ENV["POSTGRESQL_USER"] %>

<% password = ENV.key?("POSTGRESQL_ADMIN_PASSWORD") ? ENV["POSTGRESQL_ADMIN_PASSWORD"] : ENV["POSTGRESQL_PASSWORD"] %>

<% db_service = ENV.fetch("DATABASE_SERVICE_NAME","").upcase %>

default: &default

adapter: postgresql

encoding: unicode

# For details on connection pooling, see rails configuration guide

# http://guides.rubyonrails.org/configuring.html#database-pooling

pool: <%= ENV["POSTGRESQL_MAX_CONNECTIONS"] || 5 %>

username: <%= user %>

password: <%= password %>

host: <%= ENV["#{db_service}_SERVICE_HOST"] %>

port: <%= ENV["#{db_service}_SERVICE_PORT"] %>

database: <%= ENV["POSTGRESQL_DATABASE"] %>有关最终文件应该如何查找的示例,请参阅 Ruby on Rails 示例应用程序 config/database.yml。

7.3.3.3. 将应用程序存储在 Git 中

如果您尚未安装 OpenShift Container Platform,则需要安装 git。

在 OpenShift Container Platform 中构建应用程序通常需要将源代码存储在 git 存储库中,因此如果您还没有 git,则需要安装 git。

运行 ls -1 命令,确保已在 Rails 应用程序目录中。命令输出应类似于:

$ ls -1 app bin config config.ru db Gemfile Gemfile.lock lib log public Rakefile README.rdoc test tmp vendor

现在,在 Rails 应用程序目录中运行这些命令以初始化代码并将其提交给 git:

$ git init $ git add . $ git commit -m "initial commit"

提交应用程序后,您需要将其推送(push)到远程存储库。为此,您将需要一个 GitHub 帐户,用于 创建新存储库。

设置指向 git 存储库的远程存储库:

$ git remote add origin git@github.com:<namespace/repository-name>.git

之后,将应用程序推送到远程 git 存储库。

$ git push

7.3.4. 将应用程序部署到 OpenShift Container Platform

要部署 Ruby on Rails 应用程序,为应用程序创建一个新项目:

$ oc new-project rails-app --description="My Rails application" --display-name="Rails Application"

创建 rails-app 项目 后,您将自动切换到新的项目命名空间。

在 OpenShift Container Platform 中部署应用程序涉及三个步骤:

- 从 OpenShift Container Platform 的 PostgreSQL 镜像创建数据库服务。

- 从 OpenShift Container Platform 的 Ruby 2.0 构建器镜像和用来与数据库服务进行连接的 Ruby on Rails 源代码创建一个前端 service

- 为应用程序创建路由。

7.3.4.1. 创建数据库服务

您的 Rails 应用程序需要一个正在运行的 数据库服务。对于此服务,请使用 PostgeSQL 数据库镜像。

要创建 数据库服务,请使用 oc new-app 命令。您必须将一些要在数据库容器内使用的必要环境变量传递给此命令。设置用户名、密码和数据库名称需要这些环境变量。您可随意更改这些环境变量的值。我们将设置的变量如下:

- POSTGRESQL_DATABASE

- POSTGRESQL_USER

- POSTGRESQL_PASSWORD

设置这些变量可确保:

- 存在具有指定名称的数据库

- 存在具有指定名称的用户

- 用户可以使用指定密码访问指定数据库

例如:

$ oc new-app postgresql -e POSTGRESQL_DATABASE=db_name -e POSTGRESQL_USER=username -e POSTGRESQL_PASSWORD=password

若也要为数据库管理员设置密码,请将以下内容附加至上一命令中:

-e POSTGRESQL_ADMIN_PASSWORD=admin_pw

监控这个命令的进度:

$ oc get pods --watch

7.3.4.2. 创建 Frontend 服务

要将应用程序添加到 OpenShift Container Platform 中,您需要再次使用 oc new-app 命令指定应用程序所处的存储库,该仓库需要在创建数据库服务中设置数据库相关的环境变量 :

$ oc new-app path/to/source/code --name=rails-app -e POSTGRESQL_USER=username -e POSTGRESQL_PASSWORD=password -e POSTGRESQL_DATABASE=db_name -e DATABASE_SERVICE_NAME=postgresql

通过此命令,OpenShift Container Platform 会获取源代码,设置构建器镜像,构建应用程序镜像,并将新创建的镜像与 指定的环境变量 一起部署。该应用程序命名为 rails-app。

您可以通过查看 rails-app DeploymentConfig 的 JSON 文档来验证环境变量是否已添加:

$ oc get dc rails-app -o json

您应看到以下部分:

env": [

{

"name": "POSTGRESQL_USER",

"value": "username"

},

{

"name": "POSTGRESQL_PASSWORD",

"value": "password"

},

{

"name": "POSTGRESQL_DATABASE",

"value": "db_name"

},

{

"name": "DATABASE_SERVICE_NAME",

"value": "postgresql"

}

],检查构建过程:

$ oc logs -f build rails-app-1

构建完成后,您可以查看 OpenShift Container Platform 中运行的 pod。

$ oc get pods

您应看到其中一行命令以 myapp-<number>-<hash> 开头,这是您在 OpenShift Container Platform 中运行的应用程序。

在应用程序正常工作前,您需要通过运行数据库迁移脚本来初始化数据库。具体可通过两种方式实现:

- 从正在运行的前端容器手动实现:

首先,您需要使用 rsh 命令执行到 frontend 容器:

$ oc rsh <FRONTEND_POD_ID>

从容器内部运行迁移:

$ RAILS_ENV=production bundle exec rake db:migrate

如果在 development 或 test 环境中运行 Rails 应用程序,则不必指定 RAILS_ENV 环境变量。

7.3.4.3. 为您的应用程序创建路由

要通过向服务提供外部可访问的主机名(如 www.example.com )来公开服务,请使用 OpenShift Container Platform 路由。对于您的情况,需要通过键入以下命令来公开前端服务:

$ oc expose service rails-app --hostname=www.example.com

这是用户的责任来确保它们指定的主机名解析为路由器的 IP 地址。如需更多信息,请参阅 OpenShift Container Platform 文档:

7.4. 为 Maven 设置 Nexus 镜像

7.4.1. 简介

使用 Java 和 Maven 开发应用时,您很可能会构建多次。为了缩短容器集的构建时间,可将 Maven 依赖项缓存在本地 Nexus 存储库中。本教程将指导您在群集上创建 Nexus 存储库。

本教程假设您正在处理已经设置用于 Maven 的项目。如果您有兴趣将 Maven 与 Java 项目搭配使用,则强烈建议您查阅 其指南。

另外,请确定检查应用程序的镜像以获取 Maven 镜像功能。使用 Maven 的许多镜像都有 MAVEN_MIRROR_URL 环境变量,可用于简化此过程。如果它没有这一功能,请阅读 Nexus 文档 以正确配置您的构建。

另外,请确保为每个 pod 有足够的资源才能正常工作。您可能必须 编辑 Nexus 部署配置中的 Pod 模板,以请求更多资源。

7.4.2. 设置 Nexus

下载并部署官方 Nexus 容器镜像:

oc new-app sonatype/nexus

通过公开新创建的 Nexus 服务来创建路由:

oc expose svc/nexus

使用 oc get routes 查找 pod 的新外部地址。

oc get routes

输出应类似:

NAME HOST/PORT PATH SERVICES PORT TERMINATION nexus nexus-myproject.192.168.1.173.xip.io nexus 8081-tcp

- 通过导航到 HOST/PORT 下的 URL,以确认 Nexus 正在运行。若要登录 Nexus,默认的管理员用户名是 admin,密码则为 admin123。

Nexus 预配置了中央存储库,但您可能需要其他应用程序。对于许多红帽镜像,建议在 Maven 存储库中添加 jboss-ga 存储库。

7.4.2.1. 使用探测检查成功

这是设置 就绪度和存活度探测 的良好时机。这些将定期检查以查看 Nexus 是否正确运行。

$ oc set probe dc/nexus \ --liveness \ --failure-threshold 3 \ --initial-delay-seconds 30 \ -- echo ok $ oc set probe dc/nexus \ --readiness \ --failure-threshold 3 \ --initial-delay-seconds 30 \ --get-url=http://:8081/nexus/content/groups/public

7.4.2.2. 在 Nexus 中添加持久性

如果您不想持久存储,请继续 连接到 Nexus。但是,因为任何原因,您的缓存的依赖项和任何配置自定义都会丢失。

为 Nexus 创建持久卷声明(PVC),以便在运行服务器的容器集终止时不会丢失缓存的依赖项。PVC 需要集群中的可用持久性卷(PV)。如果没有 PV 可用,且您没有集群中的管理员访问权限,请系统管理员为您创建 Read/Write 持久性卷。

否则 ,请参阅 OpenShift Container Platform 中的持久性存储部分。

在 Nexus 部署配置中添加 PVC。

$ oc volumes dc/nexus --add \ --name 'nexus-volume-1' \ --type 'pvc' \ --mount-path '/sonatype-work/' \ --claim-name 'nexus-pv' \ --claim-size '1G' \ --overwrite

这会移除之前用于部署配置的 emptyDir 卷,并为挂载于 /sonatype-work 的 1GB 持久性存储添加一个声明(即存储依赖项的位置)。由于配置更改,Nexus 容器集将自动重新部署。

要验证 Nexus 是否正在运行,请在浏览器中刷新 Nexus 页面。您可以使用以下方法监控部署的进度:

$ oc get pods -w

7.4.3. 连接到 Nexus

后续步骤中演示定义使用新的 Nexus 存储库的构建。教程的其余部分将这个示例存储库 与 wildfly-100-centos7 一起用作构建器,但这些更改应该可用于任何项目。

示例构建器镜像 支持 MAVEN_MIRROR_URL 作为其环境的一部分,因此我们可以使用此 将构建器镜像指向我们的 Nexus 存储库。如果您的镜像不支持使用环境变量来配置 Maven 镜像,您可能需要修改构建器镜像,以提供正确的 Maven 设置以指向 Nexus 镜像。

$ oc new-build openshift/wildfly-100-centos7:latest~https://github.com/openshift/jee-ex.git \ -e MAVEN_MIRROR_URL='http://nexus.<Nexus_Project>:8081/nexus/content/groups/public' $ oc logs build/jee-ex-1 --follow

将 <Nexus_Project> 替换为 Nexus 存储库的项目名称。如果该项目与正在使用的应用程序位于同一个项目中,您可以删除 <Nexus_Project>.。在 OpenShift Container Platform 中了解更多有关 DNS 解析的信息。

7.4.4. 确认是否成功

在 Web 浏览器中,导航到 http://<NexusIP>:8081/nexus/content/groups/public,以确认它已存储了应用程序的依赖项。您还可以检查构建日志,以查看 Maven 是否使用 Nexus 镜像。如果成功,您应该会看到引用 URL http://nexus:8081 的输出。

7.4.5. 其它资源

7.5. OpenShift Pipeline 构建

7.5.1. 简介

无论您创建简单的网站还是复杂的微服务 Web,请使用 OpenShift Pipelines 在 OpenShift 中构建、测试、部署和推进您的应用程序。

除了标准的 Jenkins 管道语法外,OpenShift Jenkins 镜像还提供 OpenShift 域特定语言(DSL)(通过 OpenShift Jenkins 客户端插件),其旨在提供易读、简洁、全面和流畅的语法,以便与 OpenShift API 服务器进行丰富的交互,甚至能更好地控制 OpenShift 集群上的应用程序的构建、部署和推广。

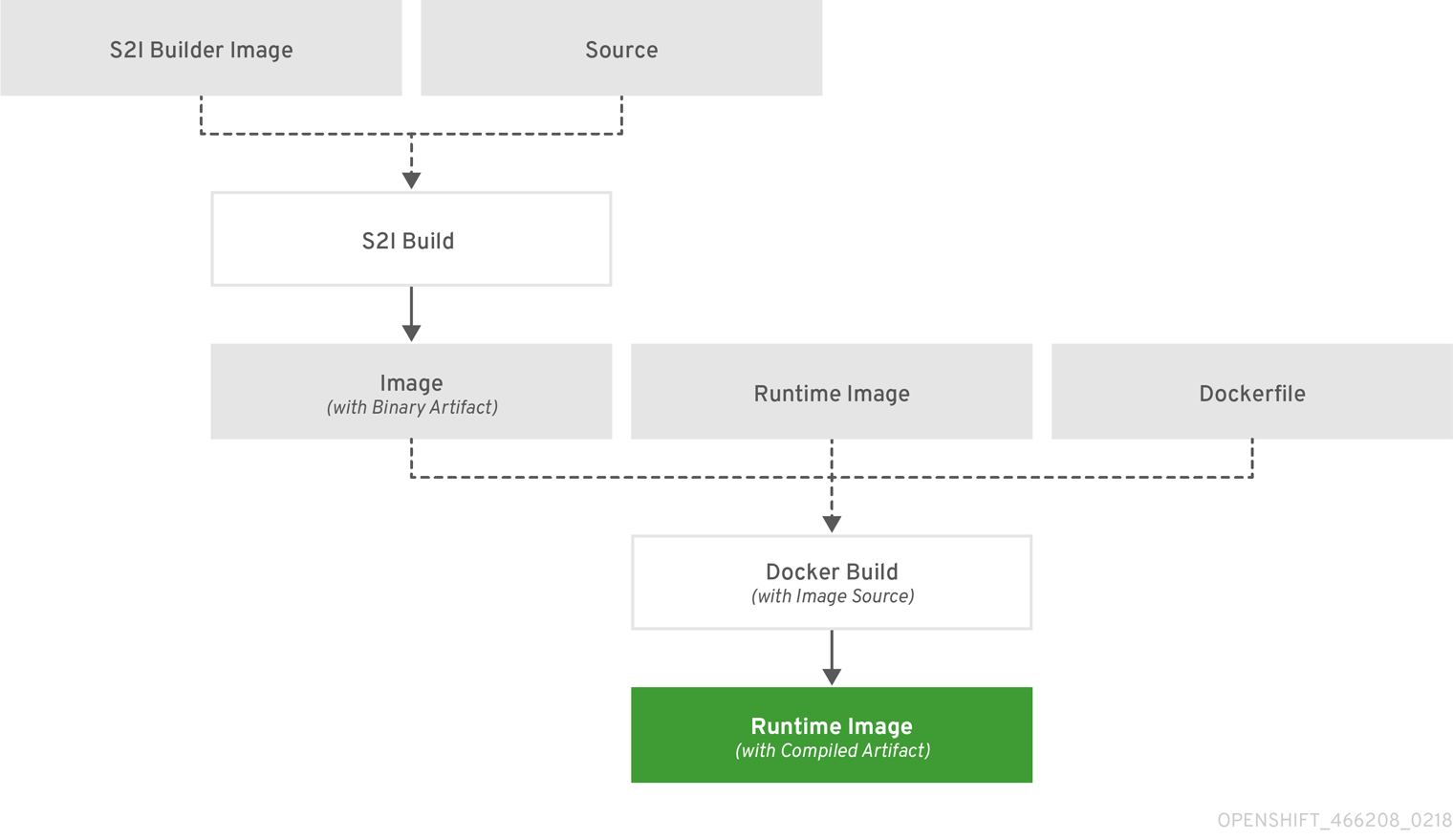

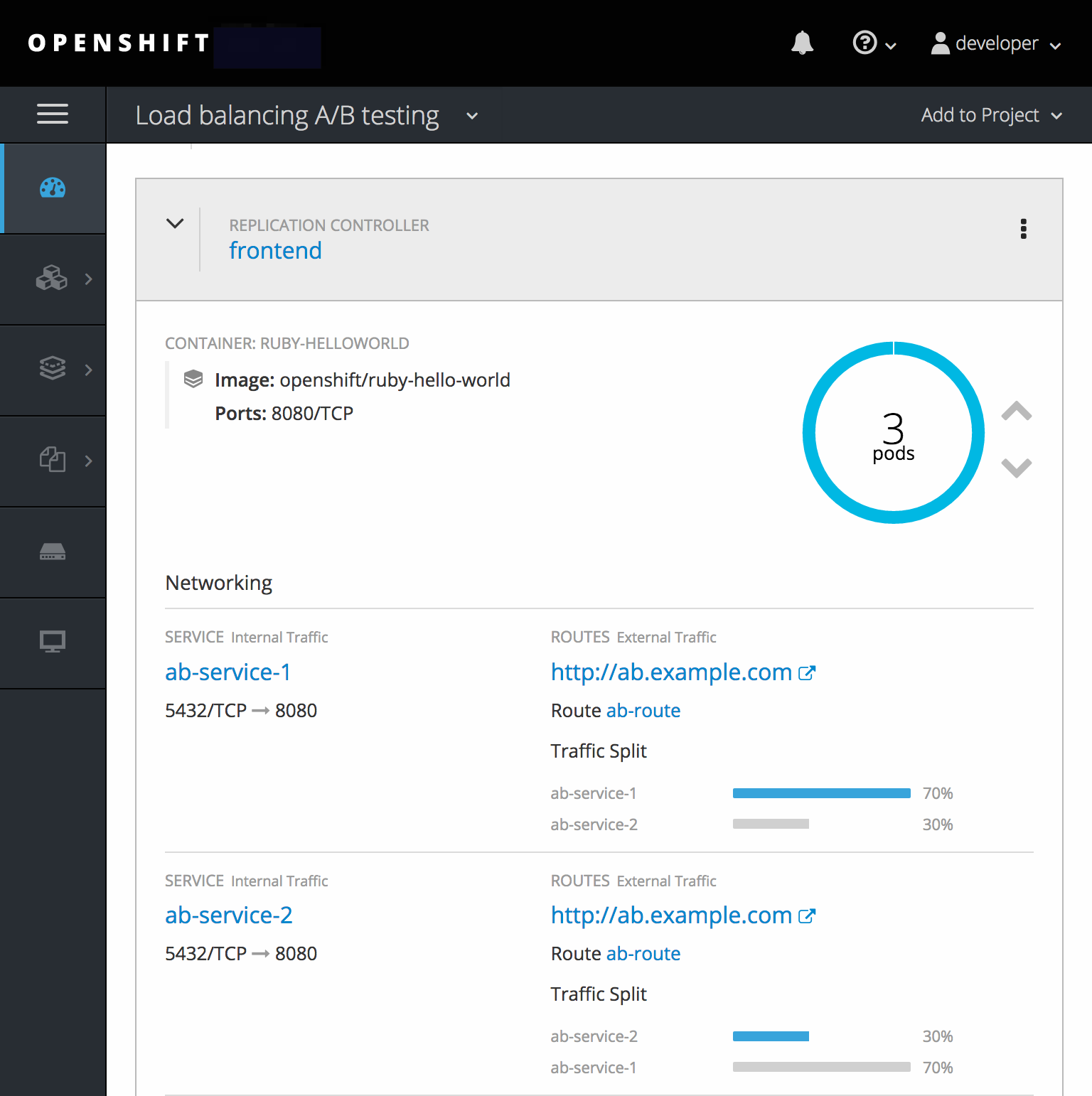

本例演示如何创建 OpenShift Pipeline,以使用 nodejs-mongodb.json 模板构建、部署和验证 Node.js/MongoDB 应用程序。

7.5.2. 创建 Jenkins Master

要创建 Jenkins master,请运行:

$ oc project <project_name> 1 $ oc new-app jenkins-ephemeral 2

如果在集群中启用了 Jenkins 自动配置,您不需要对 Jenkins master 进行任何自定义,您可以跳过上一步。

有关 Jenkins 自动置备的更多信息,请参阅配置管道执行。

7.5.3. Pipeline 构建配置

现在 Jenkins master 已启动并运行,请创建一个 BuildConfig,它将使用 Jenkins Pipeline 策略来构建、部署和扩展 Node.js/MongoDB 示例应用程序。

使用以下内容,创建名为 nodejs-sample-pipeline.yaml 的文件:

kind: "BuildConfig"

apiVersion: "v1"

metadata:

name: "nodejs-sample-pipeline"

spec:

strategy:

jenkinsPipelineStrategy:

jenkinsfile: <pipeline content from below>

type: JenkinsPipeline有关配置 Pipeline 构建策略的更多信息,请参阅 Pipeline 策略选项。

7.5.4. Jenkinsfile

使用 jenkinsPipelineStrategy 创建 BuildConfig 后,通过使用内联 jenkinsfile 告知管道做什么。本例没有为应用程序设置 Git 存储库。

以下 jenkinsfile 内容使用 OpenShift DSL 以 Groovy 语言编写。在本例中,请使用 YAML Literal Style 在 BuildConfig 中包含内联内容,但首选的方法是使用源存储库中的 jenkinsfile。

完成的 BuildConfig 可以在示例目录 nodejs-sample-pipeline.yaml 中的 OpenShift Origin 存储库中查看。

def templatePath = 'https://raw.githubusercontent.com/openshift/nodejs-ex/master/openshift/templates/nodejs-mongodb.json' 1 def templateName = 'nodejs-mongodb-example' 2 pipeline { agent { node { label 'nodejs' 3 } } options { timeout(time: 20, unit: 'MINUTES') 4 } stages { stage('preamble') { steps { script { openshift.withCluster() { openshift.withProject() { echo "Using project: ${openshift.project()}" } } } } } stage('cleanup') { steps { script { openshift.withCluster() { openshift.withProject() { openshift.selector("all", [ template : templateName ]).delete() 5 if (openshift.selector("secrets", templateName).exists()) { 6 openshift.selector("secrets", templateName).delete() } } } } } } stage('create') { steps { script { openshift.withCluster() { openshift.withProject() { openshift.newApp(templatePath) 7 } } } } } stage('build') { steps { script { openshift.withCluster() { openshift.withProject() { def builds = openshift.selector("bc", templateName).related('builds') timeout(5) { 8 builds.untilEach(1) { return (it.object().status.phase == "Complete") } } } } } } } stage('deploy') { steps { script { openshift.withCluster() { openshift.withProject() { def rm = openshift.selector("dc", templateName).rollout().latest() timeout(5) { 9 openshift.selector("dc", templateName).related('pods').untilEach(1) { return (it.object().status.phase == "Running") } } } } } } } stage('tag') { steps { script { openshift.withCluster() { openshift.withProject() { openshift.tag("${templateName}:latest", "${templateName}-staging:latest") 10 } } } } } } }

- 1

- 要使用的模板的路径。

- 2

- 要创建的模板的名称。

- 3

- 启动

node.jsslave Pod,以运行此构建。 - 4

- 为此管道设置 20 分钟超时。

- 5

- 使用此模板标签删除所有内容。

- 6

- 使用此模板标签删除任何 secret。

- 7

- 从

templatePath创建一个新应用程序。 - 8

- 等待最多五分钟以完成构建。

- 9

- 等待最多五分钟以完成部署。

- 10

- 如果其余部分都成功,则将

$ {templateName}:latest镜像标记为$ {templateName}-staging:latest。staging 环境的管道 BuildConfig 可以监控$ {templateName}-staging:latest镜像更改,然后将其部署到 stage 环境中。

上例使用 declarative pipeline 风格编写,但较旧的 scripted pipeline 风格也受到支持。

7.5.5. 创建管道

您可以通过运行以下命令,在 OpenShift 集群中创建 BuildConfig:

$ oc create -f nodejs-sample-pipeline.yaml

如果您不想自行创建文件,可以通过运行以下命令来使用 Origin 存储库中的示例:

$ oc create -f https://raw.githubusercontent.com/openshift/origin/master/examples/jenkins/pipeline/nodejs-sample-pipeline.yaml

有关此处使用的 OpenShift DSL 语法的更多信息,请参阅 OpenShift Jenkins 客户端插件。

7.5.6. 启动管道

使用以下命令启动管道:

$ oc start-build nodejs-sample-pipeline

此外,也可以通过 OpenShift Web 控制台启动管道,方法是导航到 Builds → Pipeline 部分并点击 Start Pipeline,或者访问 Jenkins 控制台,再导航到您创建的管道并点击 Build Now。

管道启动之后,您应该看到项目中执行了以下操作:

- 在 Jenkins 服务器上创建了作业实例。

- 启动了 slave Pod(如果管道需要)。

管道在 slave Pod 上运行;如果不需要 slave,则管道在 master上运行。

-

将删除之前创建的具有

template=nodejs-mongodb-example标签的所有资源。 -

从

nodejs-mongodb-example模板创建一个新应用程序及其所有相关资源。 使用

nodejs-mongodb-exampleBuildConfig 启动构建。- 管道将等待到构建完成后触发下一阶段。

使用

nodejs-mongodb-example部署配置启动部署。- 管道将等待到部署完成后触发下一阶段。

-

如果构建和部署都成功,则

nodejs-mongodb-example:latest镜像将标记为nodejs-mongodb-example:stage。

-

将删除之前创建的具有

- slave Pod(如果管道过去需要)被删除。

视觉化管道执行的最佳方法是在 OpenShift Web 控制台中查看它。您可以通过登录到 web 控制台并导航到 Builds → Pipelines 来查看管道。

7.5.7. OpenShift Pipelines 的高级选项

使用 OpenShift Pipelines,您可以在一个项目中启动 Jenkins,然后让 OpenShift 同步插件监控开发人员在其中工作的一组项目。以下小节概述了完成此过程的步骤。

避免从运行 OpenShift 同步插件的多个 Jenkins 部署中监控同一项目。这些实例之间没有协调,可能会发生不可预测的结果。

7.6. 二进制构建

7.6.1. 简介

OpenShift 中的二进制构建功能使开发人员能够将源或工件直接上传到构建中,而不是从 Git 存储库 URL 中拉取源。任何带有 source、Docker 或 custom 的 BuildConfig 都可以作为二进制构建启动。从本地工件启动构建时,现有源引用将被替换为来自本地用户机器的源。

源可以通过几种方法提供,它们对应于使用 start-build 命令时可用的参数:

-

从文件(

--from-file):当构建的整个源都包含单个文件时,这是这种情况。例如,它可能是用于 Wildfly 构建的 Docker 构建、pom.xml的Dockerfile,或用于 Ruby 构建的Gemfile。 -

目录(

--from-directory):当源位于本地目录且未提交到 Git 存储库时,使用这个选项。start-build命令将创建给定目录的存档,并将它上传到构建器,作为来源。 -

存档中的(

--from-archive):当含有源的存档已存在时,请使用此选项。归档可以是tar、tar.gz或zip格式。 -

来自 Git 存储库(

--from-repo):这适用于当前属于用户本地计算机上的 Git 存储库的来源。当前存储库的 HEAD 提交将存档,并发送到 OpenShift 以进行构建。

7.6.1.1. 使用案例

二进制构建删除了构建从现有 Git 存储库拉取源的要求。使用二进制构建的原因包括:

- 构建和测试本地代码更改.可以从公共存储库中的源克隆,可以将本地更改上传到 OpenShift 中以进行构建。本地更改不必在任何位置提交或推送。

- 构建私有代码.新的构建可以从头开始作为二进制构建。然后源可以直接从本地工作站上传到 OpenShift,而无需将其签入到 SCM。

- 使用来自其他源的工件构建镜像。使用 Jenkins 管道时,二进制构建可用于将构建工件与 Maven 或 C 编译器等工具组合使用这些构建的运行时镜像。

7.6.1.2. 限制:

- 二进制构建不可重复。因为二进制构建需要用户在启动时上传工件,所以 OpenShift 无法重复同一构建,而无需用户每次都重复执行相同的上传。

- 无法自动触发二进制构建。只有当用户上传所需的二进制工件时,才能手动启动。

作为二进制构建启动的构建可能也具有配置的源 URL。如果是这种情况,触发器将成功启动构建,但源来自配置的源 URL,而不是用户上次运行构建时提供的源 URL。

7.6.2. 教程概述

以下教程假设您有一个可用的 OpenShift 集群,并且具有可在创建工件的项目。它需要在本地同时拥有 git 和 oc。

7.6.2.1. 教程:构建本地代码更改

根据现有源存储库创建新应用,并为它创建路由:

$ oc new-app https://github.com/openshift/ruby-hello-world.git $ oc expose svc/ruby-hello-world

通过导航到路由的主机,等待初始构建完成并查看应用程序的页面。您应会收到欢迎页面:

$ oc get route ruby-hello-world

本地克隆存储库:

$ git clone https://github.com/openshift/ruby-hello-world.git $ cd ruby-hello-world

-

更改应用程序视图。使用您最喜欢的编辑器,编辑 view

/main.rb:将 <body> 标签改为<body style="background-color:blue">。 使用您的本地修改源启动新构建。在仓库的本地目录中运行:

---- $ oc start-build ruby-hello-world --from-dir="." --follow ----

构建完成后,应用程序重新部署后,导航到应用程序的路由主机会导致页面具有蓝色背景。

您可以在本地进行更改,并使用 oc start-build --from-dir 来构建代码。

您还可以创建代码分支,在本地提交更改,并使用存储库的 HEAD 作为构建的源:

$ git checkout -b my_branch $ git add . $ git commit -m "My changes" $ oc start-build ruby-hello-world --from-repo="." --follow

7.6.2.2. 教程:构建私有代码

创建存放您的代码的本地目录:

$ mkdir myapp $ cd myapp

在目录中,创建一个名为

Dockerfile的文件,其内容如下:FROM centos:centos7 EXPOSE 8080 COPY index.html /var/run/web/index.html CMD cd /var/run/web && python -m SimpleHTTPServer 8080

创建名为

index.html的文件,其内容如下:<html> <head> <title>My local app</title> </head> <body> <h1>Hello World</h1> <p>This is my local application</p> </body> </html>为您的应用程序创建新构建:

$ oc new-build --strategy docker --binary --docker-image centos:centos7 --name myapp

使用本地目录的内容启动一个二进制构建:

$ oc start-build myapp --from-dir . --follow

使用

new-app部署应用程序,然后为其创建路由:$ oc new-app myapp $ oc expose svc/myapp

获取路由的主机名并导航到它:

$ oc get route myapp

在构建并部署您的代码后,您可以通过调用 oc start-build myapp --from-dir,对本地文件进行更改并启动新的构建。构建后,代码将被自动部署,当您刷新页面时,更改将会被反映到您的浏览器中。

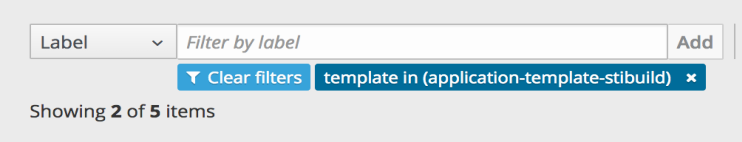

7.6.2.3. 教程:管道中的二进制工件

OpenShift 上的 Jenkins 允许在适当的工具中使用从属镜像来构建您的代码。例如,您可以使用 maven slave 从代码存储库构建 WAR。但是,构建此工件后,您需要将其提交到包含运行代码的适当运行时工件的镜像。二进制构建可用于将这些工件添加到运行时镜像中。在以下教程中,我们将创建一个 Jenkins 管道,以使用 maven slave 构建 WAR,然后使用带有 Dockerfile 的二进制构建将该 WAR 添加到 wildfly 运行时镜像中。

为您的应用程序创建新目录:

$ mkdir mavenapp $ cd mavenapp

创建一个

Dockerfile,它将 WAR 复制到 wildfly 镜像内部的适当位置,以进行执行。将以下内容复制到名为Dockerfile的本地文件中:FROM wildfly:latest COPY ROOT.war /wildfly/standalone/deployments/ROOT.war CMD $STI_SCRIPTS_PATH/run

为该 Dockerfile 创建新的 BuildConfig:

注意这将自动启动构建,该构建最初将失败,因为

ROOT.war构件还不可用。以下管道将使用二进制构建将该 WAR 传递给构建。$ cat Dockerfile | oc new-build -D - --name mavenapp

使用 Jenkins 管道创建 BuildConfig,它将构建 WAR,然后使用该 WAR 使用之前创建的

Dockerfile构建镜像。同一模式可用于由一组工具构建二进制工件的其他平台,然后与最终软件包的不同运行时镜像组合。将以下代码保存到mavenapp-pipeline.yml:apiVersion: v1 kind: BuildConfig metadata: name: mavenapp-pipeline spec: strategy: jenkinsPipelineStrategy: jenkinsfile: |- pipeline { agent { label "maven" } stages { stage("Clone Source") { steps { checkout([$class: 'GitSCM', branches: [[name: '*/master']], extensions: [ [$class: 'RelativeTargetDirectory', relativeTargetDir: 'mavenapp'] ], userRemoteConfigs: [[url: 'https://github.com/openshift/openshift-jee-sample.git']] ]) } } stage("Build WAR") { steps { dir('mavenapp') { sh 'mvn clean package -Popenshift' } } } stage("Build Image") { steps { dir('mavenapp/target') { sh 'oc start-build mavenapp --from-dir . --follow' } } } } } type: JenkinsPipeline triggers: []创建管道构建。如果 Jenkins 没有部署到项目中,使用管道创建 BuildConfig 将导致 Jenkins 部署。Jenkins 准备好构建管道前可能需要几分钟时间。您可以通过调用

oc rollout status dc/jenkins检查 Jenkins rollout 的状态:$ oc create -f ./mavenapp-pipeline.yml

Jenkins 就绪后,启动前面定义的管道:

$ oc start-build mavenapp-pipeline

当管道完成构建后,使用 new-app 部署新应用程序并公开其路由:

$ oc new-app mavenapp $ oc expose svc/mavenapp

使用您的浏览器,进入应用程序的路由:

$ oc get route mavenapp

第 8 章 Builds

8.1. 构建如何工作

8.1.1. 什么是构建?

OpenShift Container Platform 中的 构建 是将输入参数转换为结果对象的过程。大多数情况下,构建用于将源代码转换为可运行的容器镜像。

构建配置或 BuildConfig 的特征就是构建策略和一个或多个源。策略决定上述过程,而源则提供输入。

构建策略有:

- Source-to-Image (S2I) (description, options)

- Pipeline (description, options)

- Docker (description, options)

- Custom (description, options)

有六种类型的源作为构建输入提供 :

每个构建策略最多可考虑或忽略特定类型的源,并确定要使用方法。Binary 和 Git 是互斥源类型。Dockerfile 和镜像可以单独单独使用,也可以与 Git 或 Binary 一起使用。Binary 源类型在 向系统指定选项中的其它选项 中是唯一的。

8.1.2. BuildConfig 是什么?

构建配置描述了单个构建定义,以及应该创建新构建时的一组 触发器。构建配置通过 BuildConfig 定义,它是一种 REST 对象,可在对 API 服务器的 POST 中使用以创建新实例。

根据您选择使用 OpenShift Container Platform 创建应用程序的方式,如果使用 Web 控制台或 CLI,通常会自动生成 BuildConfig,并且可以随时对其进行编辑。如果选择稍后手动调整配置,则了解 BuildConfig 的组成部分及其可用选项可能会有所帮助。

以下示例 BuildConfig 在每次容器镜像标签或源代码改变时产生新的构建:

BuildConfig Object Definition

kind: "BuildConfig" apiVersion: "v1" metadata: name: "ruby-sample-build" 1 spec: runPolicy: "Serial" 2 triggers: 3 - type: "GitHub" github: secret: "secret101" - type: "Generic" generic: secret: "secret101" - type: "ImageChange" source: 4 git: uri: "https://github.com/openshift/ruby-hello-world" strategy: 5 sourceStrategy: from: kind: "ImageStreamTag" name: "ruby-20-centos7:latest" output: 6 to: kind: "ImageStreamTag" name: "origin-ruby-sample:latest" postCommit: 7 script: "bundle exec rake test"

- 1

- 此规格将创建一个名为 ruby-sample-build 的新

BuildConfig。 - 2

runPolicy字段控制从此构建配置创建的构建能否同时运行。默认值为Serial,即新构建将按顺序运行,而不是同时运行。- 3

- 您可以指定导致创建新构建的触发器的列表。

- 4

source部分定义构建的来源。源类型决定主要的输入源,可以是Git(指向代码库存储位置)、Dockerfile(从内联 Dockerfile 构建)或Binary(接受二进制有效负载)。可以同时拥有多个源,请参考每种源类型的文档。- 5

strategy部分描述用于执行构建的构建策略。您可以在此处指定Source、Docker或Custom策略。上面的示例使用ruby-20-centos7容器镜像,Source-To-Image 将用于应用程序构建。- 6

- 成功构建容器镜像后,它将被推送到

output部分中描述的存储库。 - 7

postCommit部分定义一个可选的 构建 hook。

8.2. 基本构建操作

8.2.1. 启动构建

使用以下命令,从当前项目中的现有构建配置手动启动新构建:

$ oc start-build <buildconfig_name>

使用 --from-build 标志重新运行构建:

$ oc start-build --from-build=<build_name>

指定 --follow 标志,在 stdout 中流传输构建日志:

$ oc start-build <buildconfig_name> --follow

指定 --env 标志来为构建设置任何所需的环境变量:

$ oc start-build <buildconfig_name> --env=<key>=<value>

您可以通过直接推送源来启动构建,而不依赖于 Git 源拉取或构建的 Dockerfile;源可以是 Git 或 SVN 工作目录的内容、您想要部署的一组预构建二进制工件,或者单个文件。这可以通过为 start-build 命令指定以下选项之一来完成:

| 选项 | 描述 |

|---|---|

|

| 指定将要存档并用作构建的二进制输入的目录。 |

|

| 指定将成为构建源中唯一文件的单个文件。该文件放在空目录的根目录中,其文件名与提供的原始文件相同。 |

|

|

指定用作构建二进制输入的本地存储库的路径。添加 |

将任何这些选项直接传递给构建时,内容将流传输到构建中并覆盖当前的构建源设置。

从二进制输入触发的构建不会在服务器上保留源,因此基础镜像更改触发的重新构建将使用构建配置中指定的源。

例如,以下命令将发送本地 Git 存储库的内容作为标签 v2 的存档,再启动构建:

$ oc start-build hello-world --from-repo=../hello-world --commit=v2

8.2.2. 取消构建

使用 Web 控制台或以下 CLI 命令手动取消构建:

$ oc cancel-build <build_name>

同时取消多个构建:

$ oc cancel-build <build1_name> <build2_name> <build3_name>

取消从构建配置创建的所有构建:

$ oc cancel-build bc/<buildconfig_name>

取消给定状态下的所有构建(如 new 或 pending状态),忽略其他状态下的构建:

$ oc cancel-build bc/<buildconfig_name> --state=<state>

8.2.3. 删除 BuildConfig

使用以下命令删除 BuildConfig :

$ oc delete bc <BuildConfigName>

这也会删除从此 BuildConfig 实例化的所有构建。如果您不想删除构建,请指定 --cascade=false 标志:

$ oc delete --cascade=false bc <BuildConfigName>

8.2.4. 查看构建详情

您可以使用 Web 控制台或 oc describe CLI 命令查看构建详情:

$ oc describe build <build_name>

这将显示诸如以下信息:

- 构建源

- 构建策略

- 输出目的地

- 目标 registry 中的镜像摘要

- 构建的创建方式

如果构建采用 Docker 或 Source 策略,则 oc describe 输出还包括用于构建的源修订的相关信息,包括提交 ID、作者、提交者和消息等。

8.2.5. 访问构建日志

您可以使用 Web 控制台或 CLI 访问构建日志。

直接使用构建来流传输日志:

$ oc logs -f build/<build_name>

流传输构建配置的最新构建的日志:

$ oc logs -f bc/<buildconfig_name>

返回构建配置的给定版本构建的日志:

$ oc logs --version=<number> bc/<buildconfig_name>

日志详细程度

要启用更为详细的输出,请传递 BUILD_LOGLEVEL 环境变量作为 BuildConfig 中 sourceStrategy 或 dockerStrategy 的一部分:

sourceStrategy:

...

env:

- name: "BUILD_LOGLEVEL"

value: "2" 1- 1

- 将此值调整为所需的日志级别。

平台管理员可以通过为 BuildDefaults 准入控制器配置 env/BUILD_LOGLEVEL 来设置整个 OpenShift Container Platform 实例的默认构建详细程度。此默认值可以通过在给定的 BuildConfig 中指定 BUILD_LOGLEVEL 来覆盖。您可以通过将 --build-loglevel 传递给 oc start-build,在命令行中为非二进制构建指定优先级更高的覆盖。

Source 构建的可用日志级别如下:

| 0 级 | 生成运行 assemble 脚本的容器的输出,以及所有遇到的错误。这是默认值。 |

| 1 级 | 生成有关已执行进程的基本信息。 |

| 2 级 | 生成有关已执行进程的非常详细的信息。 |

| 3 级 | 生成有关已执行进程的非常详细的信息,以及存档内容的列表。 |

| 4 级 | 目前生成与 3 级相同的信息。 |

| 5 级 | 生成以上级别中包括的所有内容,另外还提供 Docker 推送消息。 |

8.3. 构建输入

8.3.1. 构建输入如何工作

构建输入提供构建操作的源内容。在 OpenShift Container Platform 中,可以通过几种方法提供源。顺序排列:

不同的输入可以合并为一个构建。由于内联 Dockerfile 具有优先权,它可覆盖由另一个输入提供的名为 Dockerfile 的任何其他文件。二进制(本地)和 Git 存储库是互斥的输入。

当您不希望在构建生成的最终应用程序镜像中提供构建期间使用的某些资源或凭证,或者想要消耗在 Secret 资源中定义的值时,输入 secret 很有用。外部工件可用于拉取不以其他任一构建输入类型提供的额外文件。

每当运行构建时:

- 构造工作目录,并将所有输入内容放进工作目录中。例如,把输入 Git 存储库克隆到工作目录中,并且把由输入镜像指定的文件通过目标目录复制到工作目录中。

-

构建过程将目录更改到

contextDir(若已指定)。 - 内联 Dockerfile(若有)写入当前目录中。

-

当前目录中的内容提供给构建过程,供 Dockerfile、自定义构建器逻辑或 assemble 脚本引用。这意味着,构建将忽略所有驻留在

contextDir之外的输入内容。

以下源定义示例包括多种输入类型,以及它们如何组合的说明。如需有关如何定义各种输入类型的更多详细信息,请参阅每种输入类型的具体小节。

source:

git:

uri: https://github.com/openshift/ruby-hello-world.git 1

images:

- from:

kind: ImageStreamTag

name: myinputimage:latest

namespace: mynamespace

paths:

- destinationDir: app/dir/injected/dir 2

sourcePath: /usr/lib/somefile.jar

contextDir: "app/dir" 3

dockerfile: "FROM centos:7\nRUN yum install -y httpd" 48.3.2. Dockerfile 源

提供 dockerfile 值时,此字段的内容将写到磁盘上,存为名为 Dockerfile 的文件。这是处理完其他输入源之后完成的;因此,如果输入源存储库的根目录中包含 Dockerfile,它会被此内容覆盖。

此字段的典型用途是为 Docker 策略构建 提供 Dockerfile。

源定义是 BuildConfig 的 spec 部分的一部分:

source:

dockerfile: "FROM centos:7\nRUN yum install -y httpd" 1- 1

dockerfile字段包含将要构建的内联 Dockerfile。

8.3.3. 镜像源

可以通过镜像为构建过程提供额外的文件。输入镜像的引用方式与定义 From 和 To 镜像目标的方式相同。这意味着可以引用容器镜像和 镜像流标签。在使用镜像时,必须提供一个或多个路径对,以指示要复制镜像的文件或目录的路径以及构建上下文中要放置它们的目的地。

源路径可以是指定镜像内的任何绝对路径。目的地必须是相对目录路径。构建时会加载镜像,并将指定的文件和目录复制到构建过程上下文目录中。这与源存储库内容(若有)要克隆到的目录相同。如果源路径以 /. 结尾,则复制目录的内容,但不在目的地上创建该目录本身。

镜像输入在 BuildConfig 的 source 定义中指定:

source:

git:

uri: https://github.com/openshift/ruby-hello-world.git

images: 1

- from: 2

kind: ImageStreamTag

name: myinputimage:latest

namespace: mynamespace

paths: 3

- destinationDir: injected/dir 4

sourcePath: /usr/lib/somefile.jar 5

- from:

kind: ImageStreamTag

name: myotherinputimage:latest

namespace: myothernamespace

pullSecret: mysecret 6

paths:

- destinationDir: injected/dir

sourcePath: /usr/lib/somefile.jar使用 Custom 策略的构建不支持此功能。

8.3.4. Git Source

指定后,将从提供的位置获取源代码。

如果提供了内联 Dockerfile,它将覆盖 Git 存储库的 contextDir 中的 Dockerfile (若有)。

源定义是 BuildConfig 的 spec 部分的一部分:

source: git: 1 uri: "https://github.com/openshift/ruby-hello-world" ref: "master" contextDir: "app/dir" 2 dockerfile: "FROM openshift/ruby-22-centos7\nUSER example" 3

如果 ref 字段注明拉取请求,则系统将使用 git fetch 操作,然后 checkout FETCH_HEAD。

如果未提供 ref 值,OpenShift Container Platform 将执行浅克隆 (--depth=1)。这时,仅下载与默认分支(通常为 master)上最近提交相关联的文件。这将使存储库下载速度加快,但不会有完整的提交历史记录。要对指定存储库的默认分支执行完整 git clone,请将 ref 设为默认分支(如 master)的名称。

8.3.4.1. 使用代理

如果 Git 存储库需要使用代理才能访问,您可以在 BuildConfig 的 source 部分中定义要使用的代理。您可以配置要使用的 HTTP 和 HTTPS 代理。两个字段都是可选的。也可以通过 NoProxy 字段指定不应执行代理的域。

源 URI 必须使用 HTTP 或 HTTPS 协议才可以正常工作。

source:

git:

uri: "https://github.com/openshift/ruby-hello-world"

httpProxy: http://proxy.example.com

httpsProxy: https://proxy.example.com

noProxy: somedomain.com, otherdomain.com集群管理员也可使用 Ansible 为 Git 克隆配置全局代理。

对于 Pipeline 策略构建,因为 Jenkins Git 插件当前限制的缘故,通过 Git 插件执行的任何 Git 操作都不会利用 BuildConfig 中定义的 HTTP 或 HTTPS 代理。Git 插件将仅使用 Plugin Manager 面板上 Jenkins UI 中配置的代理。然后,在所有任务中,此代理都会被用于 Jenkins 内部与 git 的所有交互。您可以在 JenkinsBehindProxy 上找到有关如何通过 Jenkins UI 配置代理的说明。

8.3.4.2. 源克隆 secret

构建器 pod 需要访问定义为构建源的任何 Git 存储库。源克隆 secret 为构建器 pod 提供了通常无权访问的资源的访问权限,例如私有存储库或具有自签名或不可信 SSL 证书的存储库。

支持以下源克隆 secret 配置。

您还可以 组合使用 这些配置来满足特定的需求。

使用 builder 服务帐户运行构建,该帐户必须能够访问所使用的任何源克隆 secret。使用以下命令授予访问权限:

$ oc secrets link builder mysecret

默认情况下,“将 secret 仅限于引用它们的服务帐户”的功能被禁用。这意味着,如果在主配置文件中将 serviceAccountConfig.limitSecretReferences 设置为 false(默认设置),则不需要将 secret 连接到一个特定的服务。

8.3.4.2.1. 自动把源克隆 secret 添加到构建配置

创建 BuildConfig,OpenShift Container Platform 可以自动填充其源克隆 secret 引用。此行为允许生成的构建自动使用存储在引用的 Secret 中的凭证与远程 Git 存储库进行身份验证,而无需进一步配置。

要使用此功能,包含 Git 存储库凭证的 Secret 必须存在于稍后创建 BuildConfig 的命名空间中。此 Secret 还必须包含前缀为 build.openshift.io/source-secret-match-uri- 的一个或多个注解。这些注解中的每一个值都是 URI 模式,定义如下。如果 BuildConfig 是在没有源克隆 secret 引用的前提下创建的,并且其 Git 源 URI 与 Secret 注解中的 URI 模式匹配,OpenShift Container Platform 将自动在 BuildConfig 插入对该 Secret 的引用。

URI 模式必须包含:

-

一个有效的方案(

*://、git://、http://\https://或ssh://)。 -

一个主机(

*,或一个有效的主机名或 IP 地址(可以在之前使用*.))。 -

一个路径(

/*,或/(后面包括任意字符并可以包括*字符))。

在上述所有内容中,* 字符被认为是通配符。

URI 模式必须与符合 RFC3986 的 Git 源 URI 匹配。不要在 URI 模式中包含用户名(或密码)组件。