Red Hat Training

A Red Hat training course is available for RHEL 8

Endurecimento da segurança

Protegendo o Red Hat Enterprise Linux 8

Resumo

Tornando o código aberto mais inclusivo

A Red Hat tem o compromisso de substituir a linguagem problemática em nosso código, documentação e propriedades da web. Estamos começando com estes quatro termos: master, slave, blacklist e whitelist. Por causa da enormidade deste esforço, estas mudanças serão implementadas gradualmente ao longo de vários lançamentos futuros. Para mais detalhes, veja a mensagem de nosso CTO Chris Wright.

Fornecendo feedback sobre a documentação da Red Hat

Agradecemos sua contribuição em nossa documentação. Por favor, diga-nos como podemos melhorá-la. Para fazer isso:

Para comentários simples sobre passagens específicas:

- Certifique-se de que você está visualizando a documentação no formato Multi-page HTML. Além disso, certifique-se de ver o botão Feedback no canto superior direito do documento.

- Use o cursor do mouse para destacar a parte do texto que você deseja comentar.

- Clique no pop-up Add Feedback que aparece abaixo do texto destacado.

- Siga as instruções apresentadas.

Para enviar comentários mais complexos, crie um bilhete Bugzilla:

- Ir para o site da Bugzilla.

- Como Componente, use Documentation.

- Preencha o campo Description com sua sugestão de melhoria. Inclua um link para a(s) parte(s) relevante(s) da documentação.

- Clique em Submit Bug.

Capítulo 1. Visão geral do endurecimento da segurança na RHEL

Devido ao aumento da dependência de computadores poderosos e em rede para ajudar a administrar os negócios e manter o controle de nossas informações pessoais, setores inteiros foram formados em torno da prática da segurança de redes e computadores. As empresas solicitaram o conhecimento e as habilidades de especialistas em segurança para auditar adequadamente os sistemas e adaptar as soluções para atender às exigências operacionais de sua organização. Como a maioria das organizações é cada vez mais dinâmica por natureza, seus trabalhadores estão acessando recursos críticos de TI da empresa local e remotamente, daí a necessidade de ambientes computacionais seguros ter se tornado mais pronunciada.

Infelizmente, muitas organizações, bem como usuários individuais, consideram a segurança como mais um pensamento posterior, um processo que é negligenciado em favor do aumento de poder, produtividade, conveniência, facilidade de uso e preocupações orçamentárias. A implementação adequada da segurança é muitas vezes promulgada post-mortem - após uma intrusão não autorizada já ter ocorrido. Tomar as medidas corretas antes de conectar um site a uma rede não confiável, como a Internet, é um meio eficaz de frustrar muitas tentativas de intrusão.

1.1. O que é segurança informática?

Segurança informática é um termo geral que cobre uma ampla área de computação e processamento de informações. As indústrias que dependem de sistemas e redes de computadores para realizar transações comerciais diárias e acessar informações críticas consideram seus dados como uma parte importante de seu patrimônio geral. Vários termos e métricas entraram em nosso vocabulário comercial diário, tais como custo total de propriedade (TCO), retorno do investimento (ROI) e qualidade do serviço (QoS). Usando essas métricas, as indústrias podem calcular aspectos como integridade de dados e alta disponibilidade (HA) como parte de seus custos de planejamento e gerenciamento de processos. Em alguns setores, como o comércio eletrônico, a disponibilidade e confiabilidade dos dados pode significar a diferença entre o sucesso e o fracasso.

1.2. Padronizando a segurança

As empresas de todos os setores dependem de regulamentações e regras que são estabelecidas por organismos de normalização como a Associação Médica Americana (AMA) ou o Institute of Electrical and Electronics Engineers (IEEE). Os mesmos conceitos são válidos para a segurança da informação. Muitos consultores e fornecedores de segurança concordam com o modelo de segurança padrão conhecido como CIA, ou Confidentiality, Integrity, and Availability. Este modelo de três níveis é um componente geralmente aceito para avaliar os riscos de informações sensíveis e estabelecer uma política de segurança. A seguir, descrevemos o modelo da CIA em mais detalhes:

- Confidencialidade

- Integridade

- Disponibilidade

1.3. Software criptográfico e certificações

O Red Hat Enterprise Linux passa por várias certificações de segurança, tais como FIPS 140-2 ou Common Criteria (CC), para garantir que as melhores práticas da indústria sejam seguidas.

O RHEL 8 core crypto components O artigo Knowledgebase fornece uma visão geral dos principais componentes criptográficos do Red Hat Enterprise Linux 8, documentando quais são eles, como são selecionados, como são integrados ao sistema operacional, como suportam módulos de segurança de hardware e cartões inteligentes e como as certificações criptográficas se aplicam a eles.

1.4. Controles de segurança

A segurança de computadores é freqüentemente dividida em três categorias principais distintas, comumente referidas como controls:

- Físico

- Técnico

- Administrativo

Essas três grandes categorias definem os principais objetivos de uma implementação adequada da segurança. Dentro destes controles estão subcategorias que detalham ainda mais os controles e como implementá-los.

1.4.1. Controles físicos

O controle físico é a implementação de medidas de segurança em uma estrutura definida utilizada para impedir ou impedir o acesso não autorizado a material sensível. Exemplos de controles físicos são:

- Câmeras de vigilância em circuito fechado

- Sistemas de alarme de movimento ou térmico

- Guardas de segurança

- IDs de fotos

- Portas de aço trancadas e com fechadura de ferro

- Biometria (inclui impressão digital, voz, rosto, íris, caligrafia e outros métodos automatizados usados para reconhecer indivíduos)

1.4.2. Controles técnicos

Os controles técnicos utilizam a tecnologia como base para controlar o acesso e o uso de dados sensíveis através de uma estrutura física e sobre uma rede. Os controles técnicos são de grande alcance e abrangem tecnologias como:

- Criptografia

- Cartões inteligentes

- Autenticação da rede

- Listas de controle de acesso (ACLs)

- Software de auditoria de integridade de arquivos

1.4.3. Controles administrativos

Os controles administrativos definem os fatores humanos de segurança. Eles envolvem todos os níveis de pessoal dentro de uma organização e determinam quais usuários têm acesso a que recursos e informações por tais meios:

- Treinamento e conscientização

- Preparação para desastres e planos de recuperação

- Estratégias de recrutamento e separação de pessoal

- Registro de pessoal e contabilidade

1.5. Avaliação de vulnerabilidades

Com tempo, recursos e motivação, um atacante pode entrar em quase qualquer sistema. Todos os procedimentos e tecnologias de segurança atualmente disponíveis não podem garantir que qualquer sistema esteja completamente a salvo de intrusões. Os roteadores ajudam a proteger os gateways para a Internet. Os firewalls ajudam a proteger a borda da rede. Redes Privadas Virtuais passam dados com segurança em um fluxo criptografado. Os sistemas de detecção de intrusão advertem sobre atividades maliciosas. Entretanto, o sucesso de cada uma destas tecnologias depende de uma série de variáveis, inclusive:

- A experiência do pessoal responsável pela configuração, monitoramento e manutenção das tecnologias.

- A capacidade de remendar e atualizar serviços e kernels de forma rápida e eficiente.

- A capacidade dos responsáveis de manter uma vigilância constante sobre a rede.

Dado o estado dinâmico dos sistemas e tecnologias de dados, a segurança dos recursos corporativos pode ser bastante complexa. Devido a esta complexidade, muitas vezes é difícil encontrar recursos especializados para todos os seus sistemas. Embora seja possível ter pessoal com conhecimento em muitas áreas de segurança da informação de alto nível, é difícil reter pessoal que seja especialista em mais do que algumas áreas temáticas. Isto se deve principalmente porque cada área temática de segurança da informação requer atenção e foco constantes. A segurança da informação não fica parada.

Uma avaliação de vulnerabilidade é uma auditoria interna da segurança de sua rede e sistema; os resultados indicam a confidencialidade, integridade e disponibilidade de sua rede. Tipicamente, a avaliação de vulnerabilidade começa com uma fase de reconhecimento, durante a qual são coletados dados importantes sobre os sistemas e recursos alvo. Esta fase leva à fase de prontidão do sistema, na qual o alvo é essencialmente verificado quanto a todas as vulnerabilidades conhecidas. A fase de prontidão culmina com a fase de relatório, onde os resultados são classificados em categorias de alto, médio e baixo risco; e métodos para melhorar a segurança (ou mitigar o risco de vulnerabilidade) do alvo são discutidos

Se você realizasse uma avaliação de vulnerabilidade de sua casa, você provavelmente verificaria cada porta de sua casa para ver se elas estão fechadas e trancadas. Você também verificaria cada janela, certificando-se de que elas estejam completamente fechadas e trancadas corretamente. Este mesmo conceito se aplica a sistemas, redes e dados eletrônicos. Os usuários maliciosos são os ladrões e vândalos de seus dados. Concentre-se em suas ferramentas, mentalidade e motivações, e você poderá então reagir rapidamente às suas ações.

1.5.1. Definindo a avaliação e os testes

As avaliações de vulnerabilidades podem ser divididas em um de dois tipos: outside looking in e inside looking around.

Ao realizar uma avaliação de vulnerabilidade externa, você está tentando comprometer seus sistemas a partir do exterior. Ser externo à sua empresa lhe fornece o ponto de vista do cracker. Você vê o que um cracker vê

Quando você realiza uma avaliação de vulnerabilidade interna, você está em vantagem, pois é interno e seu status é elevado à confiança. Este é o ponto de vista que você e seus colegas de trabalho já se conectaram aos seus sistemas. Você vê servidores de impressão, servidores de arquivos, bancos de dados e outros recursos.

Há distinções notáveis entre os dois tipos de avaliações de vulnerabilidade. Ser interno de sua empresa lhe dá mais privilégios do que um forasteiro. Na maioria das organizações, a segurança é configurada para manter os intrusos de fora. Muito pouco é feito para proteger os internos da organização (tais como firewalls departamentais, controles de acesso a nível de usuário e procedimentos de autenticação de recursos internos). Normalmente, há muito mais recursos quando se olha por dentro, já que a maioria dos sistemas são internos a uma empresa. Uma vez fora da empresa, seu status não é confiável. Os sistemas e recursos disponíveis para você externamente são normalmente muito limitados.

Considere a diferença entre as avaliações de vulnerabilidade e penetration tests. Pense em uma avaliação de vulnerabilidade como o primeiro passo para um teste de penetração. As informações colhidas da avaliação são utilizadas para testes. Enquanto a avaliação é realizada para verificar a existência de furos e vulnerabilidades potenciais, o teste de penetração realmente tenta explorar os resultados.

Avaliar a infra-estrutura da rede é um processo dinâmico. A segurança, tanto da informação quanto física, é dinâmica. A realização de uma avaliação mostra uma visão geral, que pode gerar falsos positivos e falsos negativos. Um falso positivo é um resultado, onde a ferramenta encontra vulnerabilidades que na realidade não existem. Um falso negativo é quando ele omite as vulnerabilidades reais.

Os administradores de segurança são apenas tão bons quanto as ferramentas que utilizam e os conhecimentos que retêm. Pegue qualquer uma das ferramentas de avaliação atualmente disponíveis, compare-as com seu sistema, e é quase uma garantia de que existem alguns falsos positivos. Seja por falha do programa ou erro do usuário, o resultado é o mesmo. A ferramenta pode encontrar falsos positivos, ou, pior ainda, falsos negativos.

Agora que a diferença entre uma avaliação de vulnerabilidade e um teste de penetração está definida, tome as conclusões da avaliação e as reveja cuidadosamente antes de realizar um teste de penetração como parte de sua nova abordagem de melhores práticas.

Não tente explorar vulnerabilidades nos sistemas de produção. Fazer isso pode ter efeitos adversos sobre a produtividade e eficiência de seus sistemas e rede.

A lista a seguir examina alguns dos benefícios de realizar avaliações de vulnerabilidade.

- Cria um foco pró-ativo na segurança da informação.

- Encontra explorações potenciais antes que os crackers as encontrem.

- O resultado é que os sistemas são mantidos atualizados e remendados.

- Promove o crescimento e ajuda a desenvolver a experiência do pessoal.

- Suprime as perdas financeiras e a publicidade negativa.

1.5.2. Estabelecendo uma metodologia para avaliação de vulnerabilidade

Para ajudar na seleção de ferramentas para uma avaliação de vulnerabilidade, é útil estabelecer uma metodologia de avaliação de vulnerabilidade. Infelizmente, não existe uma metodologia predefinida ou aprovada pela indústria neste momento; no entanto, o bom senso e as melhores práticas podem atuar como um guia suficiente.

What is the target? Are we looking at one server, or are we looking at our entire network and everything within the network? Are we external or internal to the company? As respostas a estas perguntas são importantes, pois ajudam a determinar não apenas quais ferramentas selecionar, mas também a maneira pela qual são utilizadas.

Para saber mais sobre o estabelecimento de metodologias, consulte o seguinte website:

1.5.3. Ferramentas de avaliação de vulnerabilidades

Uma avaliação pode começar usando alguma forma de ferramenta de coleta de informações. Ao avaliar toda a rede, mapeie primeiro o layout para encontrar os hosts que estão em execução. Uma vez localizado, examine cada anfitrião individualmente. O foco nesses hosts requer outro conjunto de ferramentas. Saber quais ferramentas usar pode ser o passo mais crucial para encontrar vulnerabilidades.

As seguintes ferramentas são apenas uma pequena amostra das ferramentas disponíveis:

-

Nmapé uma ferramenta popular que pode ser usada para encontrar sistemas host e portos abertos nesses sistemas. Para instalarNmapa partir do repositórioAppStream, digite o comandoyum install nmapcomo usuárioroot. Veja a página de manualnmap(1)para mais informações. -

As ferramentas da suíte

OpenSCAP, como o utilitário de linha de comandooscape o utilitário gráficoscap-workbench, fornecem uma auditoria de conformidade totalmente automatizada. Veja Scanning the system for security compliance and vulnerabilities para mais informações. -

O Advanced Intrusion Detection Environment (

AIDE) é um utilitário que cria um banco de dados de arquivos no sistema, e depois utiliza esse banco de dados para garantir a integridade dos arquivos e detectar intrusões no sistema. Veja Verificação de integridade com AIDE para mais informações.

1.6. Ameaças à segurança

1.6.1. Ameaças à segurança da rede

As más práticas ao configurar os seguintes aspectos de uma rede podem aumentar o risco de um ataque.

Arquiteturas inseguras

Uma rede mal configurada é um ponto de entrada principal para usuários não autorizados. Deixar uma rede local aberta e baseada na confiança vulnerável à Internet altamente insegura é muito parecido com deixar uma porta entreaberta em um bairro dominado pelo crime

Redes de radiodifusão

Os administradores de sistemas freqüentemente não percebem a importância do hardware de rede em seus esquemas de segurança. Hardware simples, como hubs e roteadores, depende do princípio de transmissão ou não; ou seja, sempre que um nó transmite dados através da rede para um nó receptor, o hub ou roteador envia uma transmissão dos pacotes de dados até que o nó receptor receba e processe os dados. Este método é o mais vulnerável ao protocolo de resolução de endereços (ARP) ou ao controle de acesso à mídia (MAC), tanto por intrusos externos quanto por usuários não autorizados em hosts locais.

Servidores centralizados

Outra armadilha potencial da rede é o uso da computação centralizada. Uma medida comum de corte de custos para muitas empresas é consolidar todos os serviços em uma única máquina poderosa. Isto pode ser conveniente, pois é mais fácil de gerenciar e custa consideravelmente menos do que configurações de múltiplos servidores. Entretanto, um servidor centralizado introduz um único ponto de falha na rede. Se o servidor central for comprometido, ele pode tornar a rede completamente inútil ou pior, propensa à manipulação ou roubo de dados. Nessas situações, um servidor central torna-se uma porta aberta que permite o acesso a toda a rede.

1.6.2. Ameaças à segurança do servidor

A segurança do servidor é tão importante quanto a segurança da rede, pois os servidores muitas vezes contêm uma grande quantidade de informações vitais de uma organização. Se um servidor for comprometido, todo o seu conteúdo pode ficar disponível para o cracker roubar ou manipular à vontade. As seções seguintes detalham algumas das principais questões.

Serviços não utilizados e portos abertos

Uma instalação completa do Red Hat Enterprise Linux 8 contém mais de 1000 aplicações e pacotes de bibliotecas. Entretanto, a maioria dos administradores de servidores não optam por instalar cada pacote na distribuição, preferindo instalar uma instalação base de pacotes, incluindo várias aplicações de servidor.

Uma ocorrência comum entre os administradores de sistemas é instalar o sistema operacional sem prestar atenção a quais programas estão sendo instalados. Isto pode ser problemático porque serviços desnecessários podem ser instalados, configurados com as configurações padrão e possivelmente ativados. Isto pode causar que serviços indesejados, tais como Telnet, DHCP ou DNS, sejam executados em um servidor ou estação de trabalho sem que o administrador perceba, o que por sua vez pode causar tráfego indesejado para o servidor ou mesmo um caminho potencial para o sistema para crackers.

Serviços inigualáveis

A maioria das aplicações de servidor que estão incluídas em uma instalação padrão são peças de software sólidas e exaustivamente testadas. Tendo sido usado em ambientes de produção por muitos anos, seu código foi completamente refinado e muitos dos bugs foram encontrados e corrigidos.

Entretanto, não existe um software perfeito e sempre há espaço para mais refinamento. Além disso, os softwares mais novos muitas vezes não são tão rigorosamente testados quanto se poderia esperar, devido à sua recente chegada aos ambientes de produção ou porque podem não ser tão populares quanto outros softwares de servidor.

Desenvolvedores e administradores de sistemas frequentemente encontram bugs exploráveis em aplicações de servidor e publicam as informações sobre rastreamento de bugs e sites relacionados à segurança, tais como a lista de discussão Bugtraq (http://www.securityfocus.com) ou o site da Equipe de Resposta a Emergências de Computador (CERT) (http://www.cert.org). Embora estes mecanismos sejam uma forma eficaz de alertar a comunidade sobre as vulnerabilidades de segurança, cabe aos administradores de sistemas remendar prontamente seus sistemas. Isto é particularmente verdadeiro porque os crackers têm acesso a estes mesmos serviços de rastreamento de vulnerabilidades e usarão as informações para quebrar sistemas não remendados sempre que puderem. Uma boa administração do sistema requer vigilância, acompanhamento constante de bugs e manutenção adequada do sistema para garantir um ambiente computacional mais seguro.

Administração desatenta

Os administradores que falham em corrigir seus sistemas são uma das maiores ameaças à segurança do servidor. Isto se aplica tanto a administradores inexperientes quanto a administradores superconfiantes ou motivados.

Alguns administradores não corrigem seus servidores e estações de trabalho, enquanto outros não observam as mensagens de registro do kernel do sistema ou o tráfego de rede. Outro erro comum é quando as senhas ou chaves de serviços padrão são deixadas inalteradas. Por exemplo, alguns bancos de dados têm senhas de administração padrão porque os desenvolvedores de bancos de dados assumem que o administrador do sistema muda essas senhas imediatamente após a instalação. Se um administrador de banco de dados não alterar esta senha, mesmo um cracker inexperiente pode usar uma senha padrão amplamente conhecida para obter privilégios administrativos para o banco de dados. Estes são apenas alguns exemplos de como uma administração desatenta pode levar a servidores comprometidos.

Inerentemente inseguros, os serviços

Mesmo a organização mais vigilante pode ser vítima de vulnerabilidades se os serviços de rede que escolherem forem intrinsecamente inseguros. Por exemplo, há muitos serviços desenvolvidos sob a suposição de que são utilizados através de redes confiáveis; no entanto, esta suposição falha assim que o serviço se torna disponível através da Internet

Uma categoria de serviços de rede inseguros são aqueles que requerem nomes de usuário e senhas não criptografados para autenticação. Telnet e FTP são dois desses serviços. Se o software de checagem de pacotes estiver monitorando o tráfego entre o usuário remoto e tal serviço, nomes de usuário e senhas podem ser facilmente interceptados.

Inerentemente, tais serviços também podem cair mais facilmente no que a indústria de segurança denomina o ataque man-in-the-middle. Neste tipo de ataque, um cracker redireciona o tráfego da rede enganando um servidor de nomes craqueado na rede para apontar para sua máquina ao invés do servidor pretendido. Quando alguém abre uma sessão remota para o servidor, a máquina do atacante age como um conduto invisível, sentado em silêncio entre o serviço remoto e o usuário insuspeito que está capturando informações. Desta forma, um cracker pode reunir senhas administrativas e dados brutos sem que o servidor ou o usuário se dê conta.

Outra categoria de serviços inseguros inclui sistemas de arquivos de rede e serviços de informação como NFS ou NIS, que são desenvolvidos explicitamente para uso em LAN mas, infelizmente, são estendidos para incluir WANs (para usuários remotos). O NFS não tem, por padrão, nenhum mecanismo de autenticação ou segurança configurado para impedir que um cracker monte o compartilhamento do NFS e acesse qualquer coisa contida nele. O NIS também possui informações vitais que devem ser conhecidas por todos os computadores em uma rede, incluindo senhas e permissões de arquivos, dentro de um banco de dados de texto simples ASCII ou DBM (derivado do ASCII). Um cracker que obtém acesso a este banco de dados pode então acessar cada conta de usuário em uma rede, incluindo a conta do administrador.

Por default, o Red Hat Enterprise Linux 8 é lançado com todos esses serviços desativados. Entretanto, como os administradores muitas vezes se vêem forçados a usar esses serviços, uma configuração cuidadosa é fundamental.

1.6.3. Ameaças à segurança de estações de trabalho e PCs domésticos

Estações de trabalho e PCs domésticos podem não ser tão propensos a ataques como redes ou servidores, mas como muitas vezes contêm dados sensíveis, tais como informações de cartão de crédito, eles são alvo de crackers de sistema. As estações de trabalho também podem ser cooptadas sem o conhecimento do usuário e usadas por atacantes como máquinas "bot" em ataques coordenados. Por estas razões, conhecer as vulnerabilidades de uma estação de trabalho pode poupar aos usuários a dor de cabeça de reinstalar o sistema operacional, ou pior, de se recuperar do roubo de dados.

Más senhas

Senhas ruins são uma das maneiras mais fáceis para um atacante ter acesso a um sistema.

Aplicações de clientes vulneráveis

Embora um administrador possa ter um servidor totalmente seguro e com patches, isso não significa que os usuários remotos estejam seguros ao acessá-lo. Por exemplo, se o servidor oferece serviços Telnet ou FTP através de uma rede pública, um atacante pode capturar os nomes e senhas dos usuários em texto simples à medida que eles passam pela rede, e então usar as informações da conta para acessar a estação de trabalho do usuário remoto.

Mesmo ao utilizar protocolos seguros, como o SSH, um usuário remoto pode estar vulnerável a certos ataques se não mantiver suas aplicações clientes atualizadas. Por exemplo, clientes do protocolo SSH versão 1 são vulneráveis a um ataque de encaminhamento X de servidores SSH maliciosos. Uma vez conectado ao servidor, o atacante pode capturar silenciosamente quaisquer teclas e cliques de mouse feitos pelo cliente através da rede. Este problema foi corrigido no protocolo SSH versão 2, mas cabe ao usuário acompanhar quais aplicações têm tais vulnerabilidades e atualizá-las conforme necessário.

1.7. Explorações e ataques comuns

Tabela 1.1, “Explorações comuns” detalha algumas das explorações e pontos de entrada mais comuns usados por intrusos para acessar recursos da rede organizacional. A chave para estas explorações comuns são as explicações de como elas são realizadas e como os administradores podem proteger adequadamente sua rede contra tais ataques.

Tabela 1.1. Explorações comuns

| Exploração | Descrição | Notas |

|---|---|---|

| Senhas nulas ou padrão | Deixar senhas administrativas em branco ou usar uma senha padrão definida pelo fornecedor do produto. Isto é mais comum em hardware como roteadores e firewalls, mas alguns serviços que rodam no Linux também podem conter senhas default de administrador (embora o Red Hat Enterprise Linux 8 não seja enviado com elas). | Comumente associado com hardware de rede como roteadores, firewalls, VPNs e dispositivos de armazenamento conectado à rede (NAS). Comum em muitos sistemas operacionais antigos, especialmente aqueles que agrupam serviços (como UNIX e Windows) Os administradores às vezes criam contas de usuários privilegiados com pressa e deixam a senha nula, criando um ponto de entrada perfeito para usuários maliciosos que descobrem a conta. |

| Chaves compartilhadas por padrão | Serviços seguros, às vezes chaves de segurança padrão de pacotes para fins de desenvolvimento ou testes de avaliação. Se essas chaves forem deixadas inalteradas e colocadas em um ambiente de produção na Internet, all usuários com as mesmas chaves padrão têm acesso a esse recurso de chave compartilhada, e a qualquer informação sensível que ela contenha. | Mais comum em pontos de acesso sem fio e aparelhos de servidor seguro pré-configurados. |

| IP spoofing | Uma máquina remota atua como um nó em sua rede local, encontra vulnerabilidades com seus servidores e instala um programa de backdoor ou cavalo de Tróia para ganhar controle sobre os recursos de sua rede. | O spoofing é bastante difícil, pois envolve o atacante prever números de seqüência TCP/IP para coordenar uma conexão com sistemas alvo, mas várias ferramentas estão disponíveis para ajudar os crackers a realizar tal vulnerabilidade.

Depende dos serviços do sistema alvo (tais como |

| Espionagem | Coleta de dados que passam entre dois nós ativos em uma rede através da escuta da conexão entre os dois nós. | Este tipo de ataque funciona principalmente com protocolos de transmissão de texto simples, tais como Telnet, FTP e transferências HTTP. O atacante remoto deve ter acesso a um sistema comprometido em uma LAN para realizar tal ataque; geralmente o cracker usou um ataque ativo (como IP spoofing ou man-in-the-middle) para comprometer um sistema na LAN. Medidas preventivas incluem serviços com troca de chaves criptográficas, senhas únicas ou autenticação criptografada para evitar a bisbilhotice de senhas; uma criptografia forte durante a transmissão também é aconselhada. |

| Vulnerabilidades de serviço | Um atacante encontra uma falha ou lacuna em um serviço executado através da Internet; através desta vulnerabilidade, o atacante compromete todo o sistema e quaisquer dados que ele possa conter, e pode possivelmente comprometer outros sistemas na rede. | Serviços baseados em HTTP, como CGI, são vulneráveis à execução de comandos remotos e até mesmo ao acesso de shell interativo. Mesmo que o serviço HTTP seja executado como um usuário não-privilegiado, como "ninguém", informações como arquivos de configuração e mapas de rede podem ser lidas, ou o atacante pode iniciar um ataque de negação de serviço que drena recursos do sistema ou o torna indisponível para outros usuários. Serviços às vezes podem ter vulnerabilidades que passam despercebidas durante o desenvolvimento e testes; estas vulnerabilidades (tais como buffer overflows, onde atacantes quebram um serviço usando valores arbitrários que enchem o buffer de memória de uma aplicação, dando ao atacante um prompt de comando interativo a partir do qual podem executar comandos arbitrários) podem dar controle administrativo completo a um atacante. Os administradores devem certificar-se de que os serviços não sejam executados como usuário root, e devem ficar atentos às atualizações de correções e erratas para aplicações de fornecedores ou organizações de segurança, tais como CERT e CVE. |

| Vulnerabilidades de aplicação | Os atacantes encontram falhas em aplicações desktop e estações de trabalho (como clientes de e-mail) e executam código arbitrário, implantam cavalos de Tróia para futuros compromissos, ou sistemas de crash. Exploração adicional pode ocorrer se a estação de trabalho comprometida tiver privilégios administrativos sobre o resto da rede. | As estações de trabalho e os desktops são mais propensos à exploração, pois os trabalhadores não têm o conhecimento ou a experiência para evitar ou detectar um comprometimento; é imperativo informar as pessoas sobre os riscos que estão correndo quando instalam software não autorizado ou abrem anexos de e-mail não solicitados. As salvaguardas podem ser implementadas de modo que o software do cliente de e-mail não abra ou execute automaticamente os anexos. Além disso, a atualização automática do software da estação de trabalho usando Red Hat Network; ou outros serviços de gerenciamento de sistemas podem aliviar a carga de implementações de segurança com vários assentos. |

| Ataques de Negação de Serviço (DoS) | O atacante ou grupo de atacantes coordena contra os recursos da rede ou do servidor de uma organização, enviando pacotes não autorizados ao host alvo (seja servidor, roteador ou estação de trabalho). Isto força o recurso a ficar indisponível aos usuários legítimos. | O caso mais relatado de DoS nos EUA ocorreu em 2000. Vários sites comerciais e governamentais altamente traficados foram tornados indisponíveis por um ataque coordenado de inundação ping usando vários sistemas comprometidos com conexões de alta largura de banda agindo como zombies, ou nós de transmissão redirecionados. Os pacotes-fonte são geralmente forjados (assim como retransmitidos), tornando difícil a investigação sobre a verdadeira origem do ataque.

Avanços na filtragem de entrada (IETF rfc2267) usando |

Capítulo 2. Segurança da RHEL durante a instalação

A segurança começa antes mesmo de iniciar a instalação do Red Hat Enterprise Linux. A configuração segura de seu sistema desde o início facilita a implementação de configurações de segurança adicionais posteriormente.

2.1. BIOS e segurança UEFI

A proteção por senha do BIOS (ou equivalente) e do carregador de inicialização pode impedir que usuários não autorizados que tenham acesso físico aos sistemas inicializem usando mídia removível ou obtenham privilégios de raiz através do modo de usuário único. As medidas de segurança que você deve tomar para se proteger contra tais ataques dependem tanto da sensibilidade das informações na estação de trabalho quanto da localização da máquina.

Por exemplo, se uma máquina é utilizada em uma feira e não contém informações sensíveis, então pode não ser crítico para evitar tais ataques. Entretanto, se o laptop de um funcionário com chaves SSH privadas e não criptografadas para a rede corporativa for deixado sem supervisão nessa mesma feira comercial, isso pode levar a uma grande quebra de segurança com ramificações para toda a empresa.

Se a estação de trabalho estiver localizada em um local onde somente pessoas autorizadas ou de confiança tenham acesso, no entanto, a fixação da BIOS ou do carregador de inicialização pode não ser necessária.

2.1.1. Senhas da BIOS

As duas principais razões para proteger a BIOS de um computador por senha são[1]:

- Preventing changes to BIOS settings

- Preventing system booting

Como os métodos para definir uma senha BIOS variam entre os fabricantes de computadores, consulte o manual do computador para obter instruções específicas.

Se você esquecer a senha da BIOS, ela pode ser redefinida com jumpers na placa-mãe ou desligando a bateria CMOS. Por este motivo, é uma boa prática travar a caixa do computador, se possível. Entretanto, consulte o manual do computador ou da placa-mãe antes de tentar desconectar a bateria CMOS.

2.1.1.1. Segurança de sistemas não baseados em BIOS

Outros sistemas e arquiteturas usam programas diferentes para executar tarefas de baixo nível, aproximadamente equivalentes aos da BIOS em sistemas x86. Por exemplo, o shell Unified Extensible Firmware Interface (UEFI).

Para instruções sobre a proteção por senha de programas do tipo BIOS, consulte as instruções do fabricante.

2.2. Particionamento de discos

A Red Hat recomenda a criação de partições separadas para os diretórios /boot, /, /home, /tmp, e /var/tmp/. As razões para cada uma delas são diferentes, e vamos tratar de cada partição.

/boot- Esta partição é a primeira partição que é lida pelo sistema durante o boot up. As imagens do carregador de inicialização e do kernel que são usadas para inicializar seu sistema no Red Hat Enterprise Linux 8 são armazenadas nesta partição. Esta partição não deve ser criptografada. Se esta partição estiver incluída em / e esta partição estiver criptografada ou se tornar indisponível, seu sistema não será capaz de inicializar.

/home-

Quando os dados do usuário (

/home) são armazenados em/ao invés de em uma partição separada, a partição pode encher fazendo com que o sistema operacional se torne instável. Além disso, ao atualizar seu sistema para a próxima versão do Red Hat Enterprise Linux 8 é muito mais fácil quando você pode manter seus dados na partição/home, pois eles não serão sobregravados durante a instalação. Se a partição raiz (/) se corromper, seus dados poderão ser perdidos para sempre. Ao usar uma partição separada, há um pouco mais de proteção contra a perda de dados. Você também pode direcionar esta partição para backups freqüentes. /tmpe/var/tmp/-

Os diretórios

/tmpe/var/tmp/são usados para armazenar dados que não precisam ser armazenados por um longo período de tempo. Entretanto, se muitos dados inundarem um desses diretórios, ele pode consumir todo o seu espaço de armazenamento. Se isto acontecer e estes diretórios forem armazenados em/, então seu sistema pode se tornar instável e falhar. Por esta razão, mover estes diretórios para suas próprias partições é uma boa idéia.

Durante o processo de instalação, você tem a opção de criptografar as divisórias. Você deve fornecer uma frase-senha. Esta frase-chave serve como chave para destravar a chave de criptografia em massa, que é usada para proteger os dados da partição.

2.3. Restringindo a conectividade de rede durante o processo de instalação

Ao instalar o Red Hat Enterprise Linux 8, o meio de instalação representa um instantâneo do sistema em um determinado momento. Devido a isto, ele pode não estar atualizado com as últimas correções de segurança e pode estar vulnerável a certos problemas que foram corrigidos somente após o sistema fornecido pelo meio de instalação ter sido liberado.

Ao instalar um sistema operacional potencialmente vulnerável, sempre limite a exposição somente à zona de rede necessária mais próxima. A escolha mais segura é a zona "sem rede", o que significa deixar sua máquina desconectada durante o processo de instalação. Em alguns casos, uma conexão LAN ou intranet é suficiente enquanto a conexão à Internet é a mais arriscada. Para seguir as melhores práticas de segurança, escolha a zona mais próxima com seu repositório durante a instalação do Red Hat Enterprise Linux 8 a partir de uma rede.

2.4. Instalando a quantidade mínima de pacotes necessários

É a melhor prática instalar somente os pacotes que você usará, pois cada software em seu computador poderia conter uma vulnerabilidade. Se você estiver instalando a partir da mídia DVD, aproveite a oportunidade para selecionar exatamente quais pacotes você deseja instalar durante a instalação. Se você achar que precisa de outro pacote, você pode sempre adicioná-lo ao sistema mais tarde.

2.5. Procedimentos pós-instalação

Os seguintes passos são os procedimentos relacionados à segurança que devem ser realizados imediatamente após a instalação do Red Hat Enterprise Linux 8.

Atualize seu sistema. Digite o seguinte comando como root:

# yum updateMesmo que o serviço de firewall,

firewalld, seja ativado automaticamente com a instalação do Red Hat Enterprise Linux, há cenários onde ele pode ser explicitamente desativado, por exemplo, na configuração do kickstart. Em tal caso, recomenda-se considerar a possibilidade de habilitar novamente o firewall.Para iniciar

firewalld, digite os seguintes comandos como raiz:# systemctl start firewalld # systemctl enable firewalld

Para aumentar a segurança, desabilite os serviços de que você não precisa. Por exemplo, se não houver impressoras instaladas em seu computador, desabilite o serviço

cupsusando o seguinte comando:# systemctl disable cupsPara revisar os serviços ativos, digite o seguinte comando:

$ systemctl list-units | grep service

2.6. Instalação de um sistema RHEL 8 com o modo FIPS habilitado

Para ativar a auto-verificação do módulo criptográfico mandado pelo Federal Information Processing Standard (FIPS) Publication 140-2, você tem que operar o RHEL 8 no modo FIPS. Você pode conseguir isto através de:

- Iniciando a instalação no modo FIPS.

- Mudança do sistema para o modo FIPS após a instalação.

Para evitar a regeneração de material criptográfico chave e a reavaliação da conformidade do sistema resultante associado à conversão de sistemas já implantados, a Red Hat recomenda iniciar a instalação no modo FIPS.

2.6.1. Norma Federal de Processamento de Informações (FIPS)

A publicação Federal Information Processing Standard (FIPS) 140-2 é uma norma de segurança informática desenvolvida pelo governo dos EUA e pelo grupo de trabalho da indústria para validar a qualidade dos módulos criptográficos. Veja as publicações oficiais FIPS no NIST Computer Security Resource Center.

A norma FIPS 140-2 garante que as ferramentas criptográficas implementem seus algoritmos corretamente. Um dos mecanismos para isso é a auto-verificação em tempo de execução. Veja a norma FIPS 140-2 completa na FIPS PUB 140-2 para mais detalhes e outras especificações da norma FIPS.

Para saber mais sobre os requisitos de conformidade, consulte a página de Normas Governamentais da Red Hat.

2.6.2. Instalando o sistema com o modo FIPS habilitado

Para habilitar as auto-verificações do módulo criptográfico mandado pelo Federal Information Processing Standard (FIPS) Publication 140-2, habilite o modo FIPS durante a instalação do sistema.

A Red Hat recomenda a instalação do Red Hat Enterprise Linux 8 com o modo FIPS habilitado, ao invés de habilitar o modo FIPS mais tarde. A ativação do modo FIPS durante a instalação assegura que o sistema gere todas as chaves com algoritmos aprovados pelo FIPS e testes de monitoramento contínuo no local.

Procedimento

Adicione a opção

fips=1à linha de comando do kernel durante a instalação do sistema.Durante a etapa de seleção do software, não instale nenhum software de terceiros.

Após a instalação, o sistema inicia automaticamente no modo FIPS.

Etapas de verificação

Após o início do sistema, verifique se o modo FIPS está habilitado:

$ fips-mode-setup --check FIPS mode is enabled.

Recursos adicionais

- Consulte a seção Editando opções de inicialização na seção Executando um documento de instalação avançado da RHEL para obter mais informações sobre diferentes maneiras de editar opções de inicialização.

2.6.3. Recursos adicionais

Capítulo 3. Usando políticas criptográficas de todo o sistema

Políticas criptográficas é um componente do sistema que configura os subsistemas criptográficos centrais, cobrindo os protocolos TLS, IPSec, SSH, DNSSec, e Kerberos. Ele fornece um pequeno conjunto de políticas, que o administrador pode selecionar.

3.1. Políticas criptográficas de todo o sistema

Uma vez estabelecida uma política para todo o sistema, as aplicações na RHEL a seguem e se recusam a usar algoritmos e protocolos que não atendem à política, a menos que você solicite explicitamente a aplicação para fazê-lo. Ou seja, a política se aplica ao comportamento padrão dos aplicativos quando em execução com a configuração fornecida pelo sistema, mas você pode anulá-la se necessário.

O Red Hat Enterprise Linux 8 contém os seguintes níveis de políticas:

|

| O nível padrão da política criptográfica do sistema oferece configurações seguras para os modelos de ameaça atuais. Ele permite os protocolos TLS 1.2 e 1.3, assim como os protocolos IKEv2 e SSH2. As chaves RSA e os parâmetros Diffie-Hellman são aceitos se tiverem pelo menos 2048 bits de comprimento. |

|

|

Esta política assegura a máxima compatibilidade com o Red Hat Enterprise Linux 5 e anteriores; é menos segura devido a uma superfície de ataque maior. Além dos algoritmos e protocolos de nível |

|

| Um nível de segurança conservador que se acredita suportar qualquer ataque futuro a curto prazo. Este nível não permite o uso de SHA-1 em algoritmos de assinatura. As chaves RSA e os parâmetros Diffie-Hellman são aceitos se tiverem pelo menos 3072 bits de comprimento. |

|

|

Um nível de política que esteja em conformidade com os requisitos FIPS 140-2. Isto é usado internamente pela ferramenta |

A Red Hat ajusta continuamente todos os níveis da política de modo que todas as bibliotecas, exceto quando se utiliza a política LEGACY, forneçam padrões de segurança. Mesmo que o perfil LEGACY não forneça padrões seguros, ele não inclui nenhum algoritmo que seja facilmente explorável. Como tal, o conjunto de algoritmos habilitados ou tamanhos de chave aceitáveis em qualquer política fornecida pode mudar durante a vida útil do RHEL 8.

Tais mudanças refletem novos padrões de segurança e novas pesquisas de segurança. Se você deve garantir a interoperabilidade com um sistema específico durante toda a vida útil do RHEL 8, você deve optar por não utilizar políticas criptográficas para componentes que interagem com esse sistema.

Como uma chave criptográfica usada por um certificado no API do Portal do Cliente não atende aos requisitos da política de criptografia do sistema FUTURE, o utilitário redhat-support-tool não funciona com este nível de política no momento.

Para contornar este problema, utilize a política de criptografia DEFAULT enquanto se conecta ao API do Portal do Cliente.

Os algoritmos e cifras específicos descritos nos níveis de política como permitidos estão disponíveis somente se uma aplicação os suportar.

Ferramenta para gerenciar políticas criptográficas

Para visualizar ou alterar a atual política de criptografia do sistema, use a ferramenta update-crypto-policies, por exemplo:

$ update-crypto-policies --show DEFAULT # update-crypto-policies --set FUTURE Setting system policy to FUTURE

Para garantir que a mudança da política criptográfica seja aplicada, reinicie o sistema.

Padrões criptográficos fortes através da remoção de conjuntos e protocolos criptográficos inseguros

A lista a seguir contém conjuntos de cifras e protocolos removidos das bibliotecas criptográficas centrais no RHEL 8. Eles não estão presentes nas fontes, ou seu suporte é desativado durante a construção, de modo que as aplicações não podem usá-los.

- DES (desde RHEL 7)

- Todas as suítes de cifras de grau de exportação (desde RHEL 7)

- MD5 em assinaturas (desde RHEL 7)

- SSLv2 (desde RHEL 7)

- SSLv3 (desde RHEL 8)

- Todas as curvas ECC < 224 bits (desde RHEL 6)

- Todas as curvas ECC de campo binário (desde RHEL 6)

Suítes de cifras e protocolos desabilitados em todos os níveis de políticas

Os seguintes conjuntos de cifras e protocolos são desativados em todos os níveis da política criptográfica. Eles só podem ser habilitados através de uma configuração explícita de aplicações individuais.

- DH com parâmetros < 1024 bits

- RSA com chave de tamanho < 1024 bits

- Camélia

- ARIA

- SEED

- IDEA

- Suítes de cifras somente de integridade

- TLS CBC modo criptográfico usando SHA-384 HMAC

- AES-CCM8

- Todas as curvas ECC incompatíveis com o TLS 1.3, incluindo o secp256k1

- IKEv1 (desde RHEL 8)

Suítes de cifras e protocolos habilitados nos níveis cripto-políticos

A tabela a seguir mostra os conjuntos e protocolos de cifras habilitados em todos os quatro níveis de criptografia.

LEGACY | DEFAULT | FIPS | FUTURE | |

|---|---|---|---|---|

| IKEv1 | não | não | não | não |

| 3DES | sim | não | não | não |

| RC4 | sim | não | não | não |

| DH | min. 1024 bits | min. 2048 bits | min. 2048 bits | min. 3072 bits |

| RSA | min. 1024 bits | min. 2048 bits | min. 2048 bits | min. 3072 bits |

| DSA | sim | não | não | não |

| TLS v1.0 | sim | não | não | não |

| TLS v1.1 | sim | não | não | não |

| SHA-1 in digital signatures | sim | sim | não | não |

| CBC mode ciphers | sim | sim | sim | não |

| Symmetric ciphers with keys < 256 bits | sim | sim | sim | não |

| SHA-1 and SHA-224 signatures in certificates | sim | sim | sim | não |

Recursos adicionais

-

Para mais detalhes, consulte a página de manual

update-crypto-policies(8).

3.2. Mudando a política de criptografia de todo o sistema para o modo compatível com versões anteriores

A política padrão de criptografia de todo o sistema no Red Hat Enterprise Linux 8 não permite a comunicação usando protocolos mais antigos e inseguros. Para ambientes que requerem ser compatíveis com o Red Hat Enterprise Linux 5 e, em alguns casos, também com versões anteriores, o nível menos seguro da política LEGACY está disponível.

A mudança para o nível da política LEGACY resulta em um sistema e aplicações menos seguros.

Procedimento

Para mudar a política de criptografia de todo o sistema para o nível

LEGACY, digite o seguinte comando comoroot:# update-crypto-policies --set LEGACY Setting system policy to LEGACY

Recursos adicionais

-

Para a lista de níveis de políticas criptográficas disponíveis, consulte a página de manual

update-crypto-policies(8).

3.3. Mudando o sistema para o modo FIPS

As políticas criptográficas de todo o sistema contêm um nível de política que permite a auto-verificação dos módulos criptográficos de acordo com os requisitos da Publicação 140-2 do Federal Information Processing Standard (FIPS). A ferramenta fips-mode-setup que habilita ou desabilita o modo FIPS internamente usa o nível de política criptográfica em todo o sistema FIPS.

A Red Hat recomenda a instalação do Red Hat Enterprise Linux 8 com o modo FIPS habilitado, ao invés de habilitar o modo FIPS mais tarde. A ativação do modo FIPS durante a instalação assegura que o sistema gere todas as chaves com algoritmos aprovados pelo FIPS e testes de monitoramento contínuo no local.

Procedimento

Para mudar o sistema para o modo FIPS no RHEL 8:

# fips-mode-setup --enable Setting system policy to FIPS FIPS mode will be enabled. Please reboot the system for the setting to take effect.Reinicie seu sistema para permitir que o kernel mude para o modo FIPS:

# reboot

Etapas de verificação

Após o reinício, você pode verificar o estado atual do modo FIPS:

# fips-mode-setup --check FIPS mode is enabled.

Recursos adicionais

-

A página do homem

fips-mode-setup(8). - Lista de aplicações RHEL 8 que utilizam criptografia que não estão em conformidade com FIPS 140-2

- Para mais detalhes sobre o FIPS 140-2, consulte os Requisitos de Segurança para Módulos Criptográficos no site do National Institute of Standards and Technology (NIST).

3.4. Habilitando o modo FIPS em um contêiner

Para permitir a auto-verificação dos módulos criptográficos de acordo com as exigências do Federal Information Processing Standard (FIPS) Publicação 140-2 em um contêiner:

Pré-requisitos

- O sistema hospedeiro deve ser comutado primeiro no modo FIPS, veja Mudando o sistema para o modo FIPS.

Procedimento

-

Monte o arquivo

/etc/system-fipsno recipiente do anfitrião. Estabelecer o nível da política criptográfica FIPS no contêiner:

$ update-crypto-policies --set FIPS

RHEL 8.2 introduziu um método alternativo para mudar um contêiner para o modo FIPS. Ele requer apenas o uso do seguinte comando no contêiner:

# mount --bind /usr/share/crypto-policies/back-ends/FIPS /etc/crypto-policies/back-ends

No RHEL 8, o comando fips-mode-setup não funciona corretamente em um container e não pode ser usado para habilitar ou verificar o modo FIPS neste cenário.

3.5. Lista de aplicações RHEL usando criptografia que não está em conformidade com FIPS 140-2

A Red Hat recomenda a utilização de bibliotecas do conjunto de componentes criptográficos essenciais, uma vez que é garantido que eles passem todas as certificações criptográficas relevantes, tais como FIPS 140-2, e também sigam as políticas de criptografia do sistema RHEL.

Veja o artigo sobre componentes criptográficos do núcleo RHEL 8 para uma visão geral dos componentes criptográficos do núcleo RHEL 8, as informações sobre como são selecionados, como são integrados ao sistema operacional, como suportam módulos de segurança de hardware e cartões inteligentes, e como as certificações criptográficas se aplicam a eles.

Além da tabela a seguir, em alguns lançamentos da RHEL 8 Z-stream (por exemplo, 8.1.1), os pacotes do navegador Firefox foram atualizados e contêm uma cópia separada da biblioteca de criptografia NSS. Desta forma, a Red Hat quer evitar a interrupção do rebase de um componente de tão baixo nível em um lançamento de patch. Como resultado, estes pacotes Firefox não usam um módulo validado FIPS 140-2.

Tabela 3.1. Lista de aplicações RHEL 8 que utilizam criptografia que não está em conformidade com FIPS 140-2

| Aplicação | Detalhes |

|---|---|

| FreeRADIUS | O protocolo RADIUS utiliza o MD5 |

| ghostscript | Cripto próprio (MD5, RC4, SHA-2, AES) para criptografar e decodificar documentos |

| ipxe | A pilha criptográfica para TLS é compilada em, no entanto, não é utilizada |

| java-1.8.0-openjdk | Empilhamento criptográfico completo[a] |

| libica | Fallbacks de software para vários algoritmos, tais como RSA e ECDH através de instruções CPACF |

| Ovmf (firmware UEFI), Edk2, shim | Pilha criptográfica completa (uma cópia embutida da biblioteca OpenSSL) |

| perl-Digest-HMAC | HMAC, HMAC-SHA1, HMAC-MD5 |

| perl-Digest-SHA | SHA-1, SHA-224, .. |

| pidgin | DES, RC4 |

| samba[b] | AES, DES, RC4 |

| valgrind | AES, hashes[c] |

[a]

No RHEL 8.1, o java-1.8.0-openjdk requer configuração manual adicional para ser compatível com o FIPS.

[b]

A partir do RHEL 8.3, o samba usa criptografia compatível com FIPS.

[c]

Re-implementos em operações de hardware de software, tais como AES-NI.

| |

3.6. Excluindo uma aplicação de seguir as políticas de criptografia de todo o sistema

Você pode personalizar as configurações criptográficas usadas por sua aplicação, de preferência configurando as suítes de cifras suportadas e os protocolos diretamente na aplicação.

Você também pode remover um link simbólico relacionado à sua aplicação do diretório /etc/crypto-policies/back-ends e substituí-lo por suas configurações criptográficas personalizadas. Esta configuração impede o uso de políticas criptográficas de todo o sistema para aplicações que utilizam o back end excluído. Além disso, esta modificação não é suportada pela Red Hat.

3.6.1. Exemplos de exclusão de políticas de criptografia de todo o sistema

wget

Para personalizar as configurações criptográficas usadas pelo downloader da rede wget, use as opções --secure-protocol e --ciphers. Por exemplo:

$ wget --secure-protocol=TLSv1_1 --ciphers="SECURE128" https://example.com

Consulte a seção Opções HTTPS (SSL/TLS) da página de manual wget(1) para mais informações.

enrolar

Para especificar as cifras usadas pela ferramenta curl, use a opção --ciphers e forneça uma lista de cifras separadas por dois pontos como um valor. Por exemplo:

$ curl https://example.com --ciphers '@SECLEVEL=0:DES-CBC3-SHA:RSA-DES-CBC3-SHA'

Consulte a página de manual curl(1) para mais informações.

Firefox

Mesmo que você não possa optar por não participar das políticas de criptografia do sistema no navegador Firefox, você pode restringir ainda mais as cifras suportadas e as versões TLS no Editor de Configuração do Firefox. Digite about:config na barra de endereço e altere o valor da opção security.tls.version.min conforme necessário. Definindo security.tls.version.min como 1 permite TLS 1.0 como o mínimo exigido, security.tls.version.min 2 permite TLS 1.1, e assim por diante.

OpenSSH

Para optar pela exclusão das políticas de criptografia de todo o sistema para seu servidor OpenSSH, descomente a linha com a variável CRYPTO_POLICY= no arquivo /etc/sysconfig/sshd. Após esta mudança, os valores que você especificar nas seções Ciphers, MACs, KexAlgoritms, e GSSAPIKexAlgorithms no arquivo /etc/ssh/sshd_config não serão sobrepostos. Consulte a página de manual sshd_config(5) para maiores informações.

Libreswan

Consulte o documento Configuring IPsec connections that opt out of the system-wide crypto policies no documento Securing networks para obter informações detalhadas.

Recursos adicionais

-

Para mais detalhes, consulte a página de manual

update-crypto-policies(8).

3.7. Personalização de políticas criptográficas em todo o sistema com modificadores de políticas

Use este procedimento para ajustar certos algoritmos ou protocolos de qualquer nível de política criptográfica de todo o sistema ou uma política totalmente personalizada.

A personalização de políticas criptográficas de todo o sistema está disponível na RHEL 8.2.

Procedimento

Checkout para o diretório

/etc/crypto-policies/policies/modules/:# cd /etc/crypto-policies/policies/modules/Crie módulos de políticas para seus ajustes, por exemplo:

# touch MYCRYPTO1.pmod # touch NO-AES128.pmod

ImportanteUse letras maiúsculas nos nomes dos arquivos dos módulos de políticas.

Abra os módulos de política em um editor de texto de sua escolha e insira opções que modificam a política criptográfica de todo o sistema, por exemplo:

# vi MYCRYPTO1.pmodsha1_in_certs = 0 min_rsa_size = 3072

# vi NO-AES128.pmodcipher = -AES-128-GCM -AES-128-CCM -AES-128-CTR -AES-128-CBC

- Salvar as mudanças nos arquivos do módulo.

Aplique seus ajustes de política ao nível da política criptográfica do sistema

DEFAULT:# update-crypto-policies --set DEFAULT:MYCRYPTO1:NO-AES128Para tornar suas configurações criptográficas efetivas para serviços e aplicações já em execução, reinicie o sistema:

# reboot

Recursos adicionais

-

Para mais detalhes, consulte a seção

Custom Policiesna página de manualupdate-crypto-policies(8)e a seçãoCrypto Policy Definition Formatna página de manualcrypto-policies(7). - O artigo Como personalizar políticas criptográficas no RHEL 8.2 fornece exemplos adicionais de personalização de políticas criptográficas em todo o sistema.

3.8. Desabilitando o SHA-1 através da personalização de uma política de criptografia de todo o sistema

A função hash SHA-1 tem um design inerentemente fraco e o avanço da criptanálise a tornou vulnerável a ataques. Por padrão, a RHEL 8 não usa SHA-1, mas algumas aplicações de terceiros, por exemplo, assinaturas públicas, ainda usam SHA-1. Para desativar o uso do SHA-1 em algoritmos de assinatura em seu sistema, você pode usar o módulo de política NO-SHA1.

O módulo para desativação do SHA-1 está disponível na RHEL 8.3. A personalização das políticas criptográficas de todo o sistema está disponível na RHEL 8.2.

Procedimento

Aplique seus ajustes de política ao nível da política criptográfica do sistema

DEFAULT:# update-crypto-policies --set DEFAULT:NO-SHA1Para tornar suas configurações criptográficas efetivas para serviços e aplicações já em execução, reinicie o sistema:

# reboot

Recursos adicionais

-

Para mais detalhes, consulte a seção

Custom Policiesna página de manualupdate-crypto-policies(8)e a seçãoCrypto Policy Definition Formatna página de manualcrypto-policies(7). - O post do blog Como personalizar as políticas de criptografia no RHEL 8.2 fornece exemplos adicionais de personalização de políticas criptográficas em todo o sistema.

3.9. Criação e definição de uma política criptográfica personalizada para todo o sistema

Os passos seguintes demonstram a personalização das políticas criptográficas de todo o sistema através de um arquivo completo de políticas.

A personalização de políticas criptográficas de todo o sistema está disponível na RHEL 8.2.

Procedimento

Crie um arquivo de políticas para suas personalizações:

# cd /etc/crypto-policies/policies/ # touch MYPOLICY.pol

Alternativamente, comece copiando um dos quatro níveis de política pré-definidos:

# cp /usr/share/crypto-policies/policies/DEFAULT.pol /etc/crypto-policies/policies/MYPOLICY.polEdite o arquivo com sua política de criptografia personalizada em um editor de texto de sua escolha para atender às suas exigências, por exemplo:

# vi /etc/crypto-policies/policies/MYPOLICY.polMude a política de criptografia de todo o sistema para seu nível personalizado:

# update-crypto-policies --set MYPOLICYPara tornar suas configurações criptográficas efetivas para serviços e aplicações já em execução, reinicie o sistema:

# reboot

Recursos adicionais

-

Para mais detalhes, consulte a seção

Custom Policiesna página de manualupdate-crypto-policies(8)e a seçãoCrypto Policy Definition Formatna página de manualcrypto-policies(7). - O artigo Como personalizar políticas criptográficas no RHEL 8.2 fornece exemplos adicionais de personalização de políticas criptográficas em todo o sistema.

3.10. Informações relacionadas

- Veja as políticas de criptografia de todo o sistema no RHEL 8 e Padrões criptográficos fortes no RHEL 8 e a depreciação de algoritmos criptográficos fracos Artigos da Base de Conhecimento no Portal do Cliente da Red Hat para mais informações.

Capítulo 4. Configuração de aplicações para usar hardware criptográfico através do PKCS #11

A separação de partes de suas informações secretas em dispositivos criptográficos dedicados, tais como cartões inteligentes e fichas criptográficas para autenticação do usuário final e módulos de segurança de hardware (HSM) para aplicações de servidor, proporciona uma camada adicional de segurança. No Red Hat Enterprise Linux 8, o suporte para hardware criptográfico através da API PKCS #11 é consistente entre diferentes aplicações, e o isolamento de segredos em hardware criptográfico não é uma tarefa complicada.

4.1. Suporte de hardware criptográfico através do PKCS #11

O PKCS #11 (Public-Key Cryptography Standard) define uma interface de programação de aplicação (API) para dispositivos criptográficos que contêm informações criptográficas e realizam funções criptográficas. Estes dispositivos são chamados tokens, e podem ser implementados em forma de hardware ou software.

Uma ficha PKCS #11 pode armazenar vários tipos de objetos, incluindo um certificado; um objeto de dados; e uma chave pública, privada ou secreta. Estes objetos são unicamente identificáveis através do esquema PKCS #11 URI.

Um PKCS #11 URI é uma forma padrão de identificar um objeto específico em um módulo PKCS #11 de acordo com os atributos do objeto. Isto permite configurar todas as bibliotecas e aplicações com a mesma cadeia de configuração na forma de um URI.

O Red Hat Enterprise Linux 8 fornece por default o driver OpenSC PKCS #11 para cartões inteligentes. Entretanto, os tokens de hardware e HSMs podem ter seus próprios módulos PKCS #11 que não têm sua contraparte no Red Hat Enterprise Linux. Você pode registrar tais módulos PKCS #11 com a ferramenta p11-kit, que atua como um invólucro sobre os drivers de Cartão Smart Card registrados no sistema.

Para fazer seu próprio módulo PKCS #11 funcionar no sistema, adicione um novo arquivo de texto ao diretório /etc/pkcs11/modules/

Você pode adicionar seu próprio módulo PKCS #11 ao sistema, criando um novo arquivo de texto no diretório /etc/pkcs11/modules/. Por exemplo, o arquivo de configuração do OpenSC em p11-kit tem a seguinte aparência:

$ cat /usr/share/p11-kit/modules/opensc.module

module: opensc-pkcs11.so4.2. Usando chaves SSH armazenadas em um cartão inteligente

O Red Hat Enterprise Linux 8 permite que você use chaves RSA e ECDSA armazenadas em um cartão inteligente em clientes OpenSSH. Use este procedimento para habilitar a autenticação usando um Cartão Smart Card ao invés de usar uma senha.

Pré-requisitos

-

No lado do cliente, o pacote

openscestá instalado e o serviçopcscdestá funcionando.

Procedimento

Liste todas as chaves fornecidas pelo módulo OpenSC PKCS #11 incluindo seus PKCS #11 URIs e salve a saída para o arquivo keys.pub:

$ ssh-keygen -D pkcs11: > keys.pub $ ssh-keygen -D pkcs11: ssh-rsa AAAAB3NzaC1yc2E...KKZMzcQZzx pkcs11:id=%02;object=SIGN%20pubkey;token=SSH%20key;manufacturer=piv_II?module-path=/usr/lib64/pkcs11/opensc-pkcs11.so ecdsa-sha2-nistp256 AAA...J0hkYnnsM= pkcs11:id=%01;object=PIV%20AUTH%20pubkey;token=SSH%20key;manufacturer=piv_II?module-path=/usr/lib64/pkcs11/opensc-pkcs11.so

Para permitir a autenticação usando um cartão inteligente em um servidor remoto (example.com), transfira a chave pública para o servidor remoto. Use o comando

ssh-copy-idcom keys.pub criado na etapa anterior:$ ssh-copy-id -f -i keys.pub username@example.comPara conectar-se a example.com usando a chave ECDSA da saída do comando

ssh-keygen -Dno passo 1, você pode usar apenas um subconjunto do URI, que faz referência única à sua chave, por exemplo:$ ssh -i "pkcs11:id=%01?module-path=/usr/lib64/pkcs11/opensc-pkcs11.so" example.com Enter PIN for 'SSH key': [example.com] $Você pode usar a mesma cadeia URI no arquivo

~/.ssh/configpara tornar a configuração permanente:$ cat ~/.ssh/config IdentityFile "pkcs11:id=%01?module-path=/usr/lib64/pkcs11/opensc-pkcs11.so" $ ssh example.com Enter PIN for 'SSH key': [example.com] $

Como o OpenSSH usa a embalagem

p11-kit-proxye o módulo OpenSC PKCS #11 está registrado no Kit PKCS #11, você pode simplificar os comandos anteriores:$ ssh -i "pkcs11:id=%01" example.com Enter PIN for 'SSH key': [example.com] $

Se você pular a parte id= de um PKCS #11 URI, o OpenSSH carrega todas as chaves que estão disponíveis no módulo proxy. Isto pode reduzir a quantidade de digitação necessária:

$ ssh -i pkcs11: example.com

Enter PIN for 'SSH key':

[example.com] $Recursos adicionais

- Fedora 28: Melhor suporte a cartões inteligentes no OpenSSH

-

p11-kit(8)página do homem -

ssh(1)página do homem -

ssh-keygen(1)página do homem -

opensc.conf(5)página do homem -

pcscd(8)página do homem

4.3. Usando HSMs protegendo chaves privadas em Apache e Nginx

Os servidores HTTP Apache e Nginx podem trabalhar com chaves privadas armazenadas em módulos de segurança de hardware (HSMs), o que ajuda a evitar a revelação das chaves e ataques "man-in-the-middle". Note que isto normalmente requer HSMs de alto desempenho para servidores ocupados.

Apache Servidor HTTP

Para uma comunicação segura na forma do protocolo HTTPS, o servidor Apache HTTP (httpd) utiliza a biblioteca OpenSSL. A OpenSSL não suporta o PKCS #11 nativamente. Para utilizar HSMs, é necessário instalar o pacote openssl-pkcs11, que fornece acesso aos módulos PKCS #11 através da interface do motor. Você pode usar um URI PKCS #11 em vez de um nome de arquivo comum para especificar uma chave de servidor e um certificado no arquivo de configuração /etc/httpd/conf.d/ssl.conf, por exemplo:

SSLCertificateFile "pkcs11:id=%01;token=softhsm;type=cert" SSLCertificateKeyFile "pkcs11:id=%01;token=softhsm;type=private?pin-value=111111"

Instale o pacote httpd-manual para obter a documentação completa para o Servidor HTTP Apache, incluindo a configuração TLS. As diretrizes disponíveis no arquivo de configuração /etc/httpd/conf.d/ssl.conf são descritas em detalhes em /usr/share/httpd/manual/mod/mod_ssl.html.

Nginx Servidor HTTP e proxy

Como Nginx também usa o OpenSSL para operações criptográficas, o suporte para o PKCS #11 deve passar pelo motor openssl-pkcs11. Nginx atualmente suporta apenas o carregamento de chaves privadas de um HSM, e um certificado deve ser fornecido separadamente como um arquivo regular. Modifique as opções ssl_certificate e ssl_certificate_key na seção server do arquivo de configuração /etc/nginx/nginx.conf:

ssl_certificate /path/to/cert.pem ssl_certificate_key "engine:pkcs11:pkcs11:token=softhsm;id=%01;type=private?pin-value=111111";

Note que o prefixo engine:pkcs11: é necessário para o PKCS #11 URI no arquivo de configuração Nginx. Isto porque o outro prefixo pkcs11 se refere ao nome do motor.

4.4. Configuração de aplicações para autenticar usando certificados de cartões inteligentes

O downloader da rede

wgetpermite especificar PKCS #11 URIs em vez de caminhos para chaves privadas armazenadas localmente, e assim simplifica a criação de scripts para tarefas que requerem chaves privadas e certificados armazenados com segurança. Por exemplo, o PKCS #11 URIs:$ wget --private-key 'pkcs11:token=softhsm;id=;type=private?pin-value=11111111' --certificado 'pkcs11:token=softhsm;id=;type=cert' https://example.com/

Consulte a página de manual

wget(1)para mais informações.A especificação do PKCS #11 URI para uso pela ferramenta

curlé análoga:$ curl --key 'pkcs11:token=softhsm;id=;type=private?pin-value=11111111' --cert 'pkcs11:token=softhsm;id=;type=cert' https://example.com/

Consulte a página de manual

curl(1)para mais informações.-

O navegador web

Firefoxcarrega automaticamente o módulop11-kit-proxy. Isto significa que cada Cartão Smart Card suportado no sistema é detectado automaticamente. Para usar a autenticação do cliente TLS, nenhuma configuração adicional é necessária e as chaves de um Cartão Smart Card são automaticamente usadas quando um servidor as solicita.

Usando o PKCS #11 URIs em aplicações personalizadas

Se sua aplicação utiliza a biblioteca GnuTLS ou NSS, o suporte para o PKCS #11 URIs é garantido por seu suporte integrado ao PKCS #11. Além disso, as aplicações que dependem da biblioteca OpenSSL podem acessar módulos de hardware criptográfico graças ao motor openssl-pkcs11.

Com aplicações que requerem trabalhar com chaves privadas em cartões inteligentes e que não usam NSS, GnuTLS, ou OpenSSL, use p11-kit para implementar o registro dos módulos PKCS #11.

Consulte a página de manual p11-kit(8) para mais informações.

4.5. Informações relacionadas

-

pkcs11.conf(5)página do homem

Capítulo 5. Usando certificados de sistema compartilhado

O armazenamento de certificados de sistema compartilhado permite que NSS, GnuTLS, OpenSSL e Java compartilhem uma fonte padrão para a recuperação de âncoras de certificados de sistema e informações de listas de bloqueio. Por padrão, a loja de confiança contém a lista da Mozilla CA, incluindo confiança positiva e negativa. O sistema permite atualizar a lista principal da Mozilla CA ou escolher outra lista de certificados.

5.1. A loja de confiança em todo o sistema

No Red Hat Enterprise Linux, a loja de confiança consolidada em todo o sistema está localizada nos diretórios /etc/pki/ca-trust/ e /usr/share/pki/ca-trust-source/. As configurações de confiança em /usr/share/pki/ca-trust-source/ são processadas com prioridade menor do que as configurações em /etc/pki/ca-trust/.

Os arquivos de certificados são tratados de acordo com o subdiretório em que são instalados nos seguintes diretórios:

para âncoras de confiança

-

/usr/share/pki/ca-trust-source/anchors/ou -

/etc/pki/ca-trust/source/anchors/

-

para certificados duvidosos

-

/usr/share/pki/ca-trust-source/blacklist/ou -

/etc/pki/ca-trust/source/blacklist/

-

para certificados no formato de arquivo BEGIN TRUSTED estendido

-

/usr/share/pki/ca-trust-source/ou -

/etc/pki/ca-trust/source/

-

Em um sistema criptográfico hierárquico, uma âncora de confiança é uma entidade autorizada, que outras partes consideram ser confiável. Na arquitetura X.509, um certificado de raiz é uma âncora de confiança da qual se deriva uma cadeia de confiança. Para permitir a validação da cadeia, a parte confiante deve ter acesso primeiro à âncora de confiança.

5.2. Acréscimo de novos certificados

Para reconhecer aplicações em seu sistema com uma nova fonte de confiança, adicione o certificado correspondente à loja em todo o sistema, e use o comando update-ca-trust.

Pré-requisitos

-

O pacote

ca-certificatesestá presente no sistema.

Procedimento

Para adicionar um certificado nos formatos simples de arquivo PEM ou DER à lista de CAs confiáveis no sistema, copie o arquivo do certificado para o diretório

/usr/share/pki/ca-trust-source/anchors/ou/etc/pki/ca-trust/source/anchors/, por exemplo:# cp ~/certificate-trust-examples/Cert-trust-test-ca.pem /usr/share/pki/ca-trust-source/anchors/Para atualizar a configuração da loja de confiança em todo o sistema, use o comando

update-ca-trust:# update-ca-trust

Enquanto o navegador Firefox é capaz de usar um certificado adicional sem executar update-ca-trust, a Red Hat recomenda usar o comando update-ca-trust após uma mudança de CA. Observe também que navegadores, como Firefox, Epiphany ou Chromium, arquivos cache, e você pode ter que limpar o cache do navegador ou reiniciar seu navegador para carregar a configuração atual dos certificados do sistema.

5.3. Gerenciando certificados de sistema confiáveis

O comando trust fornece uma maneira conveniente para gerenciar certificados na loja de confiança compartilhada em todo o sistema.

Para listar, extrair, adicionar, remover ou alterar âncoras de confiança, use o comando

trust. Para ver a ajuda embutida para este comando, insira-o sem nenhum argumento ou com a diretiva--help:$ trust usage: trust command <args>... Common trust commands are: list List trust or certificates extract Extract certificates and trust extract-compat Extract trust compatibility bundles anchor Add, remove, change trust anchors dump Dump trust objects in internal format See 'trust <command> --help' for more informationPara listar todas as âncoras e certificados de confiança do sistema, use o comando

trust list:$ trust list pkcs11:id=%d2%87%b4%e3%df%37%27%93%55%f6%56%ea%81%e5%36%cc%8c%1e%3f%bd;type=cert type: certificate label: ACCVRAIZ1 trust: anchor category: authority pkcs11:id=%a6%b3%e1%2b%2b%49%b6%d7%73%a1%aa%94%f5%01%e7%73%65%4c%ac%50;type=cert type: certificate label: ACEDICOM Root trust: anchor category: authority ...Para armazenar uma âncora de confiança na loja de confiança do sistema, use o sub-comando

trust anchore especifique um caminho para um certificado. Substitua path.to/certificate.crt por um caminho para seu certificado e seu nome de arquivo:# trust anchor path.to/certificate.crtPara remover um certificado, use um caminho para um certificado ou uma identificação de um certificado:

# trust anchor --remove path.to/certificate.crt # trust anchor --remove "pkcs11:id=%AA%BB%CC%DD%EE;type=cert"

Recursos adicionais

Todos os subcomandos dos comandos

trustoferecem uma ajuda embutida detalhada, por exemplo:$ trust list --help usage: trust list --filter=<what> --filter=<what> filter of what to export ca-anchors certificate anchors ... --purpose=<usage> limit to certificates usable for the purpose server-auth for authenticating servers ...

5.4. Recursos adicionais

Para mais informações, consulte as seguintes páginas de homem:

-

update-ca-trust(8) -

trust(1)

Capítulo 6. Verificação do sistema para conformidade e vulnerabilidades de configuração

Uma auditoria de conformidade é um processo para determinar se um determinado objeto segue todas as regras especificadas em uma política de conformidade. A política de conformidade é definida por profissionais de segurança que especificam as configurações necessárias, muitas vezes na forma de uma lista de verificação, que um ambiente de computação deve utilizar.

As políticas de conformidade podem variar substancialmente entre organizações e até mesmo entre diferentes sistemas dentro de uma mesma organização. As diferenças entre estas políticas são baseadas no propósito de cada sistema e sua importância para a organização. As configurações personalizadas do software e as características de implantação também levantam uma necessidade de listas de verificação de políticas personalizadas.

6.1. Ferramentas de conformidade de configuração na RHEL

O Red Hat Enterprise Linux fornece ferramentas que permitem que você realize uma auditoria de conformidade totalmente automatizada. Estas ferramentas são baseadas no padrão Security Content Automation Protocol (SCAP) e são projetadas para a adaptação automatizada das políticas de conformidade.

-

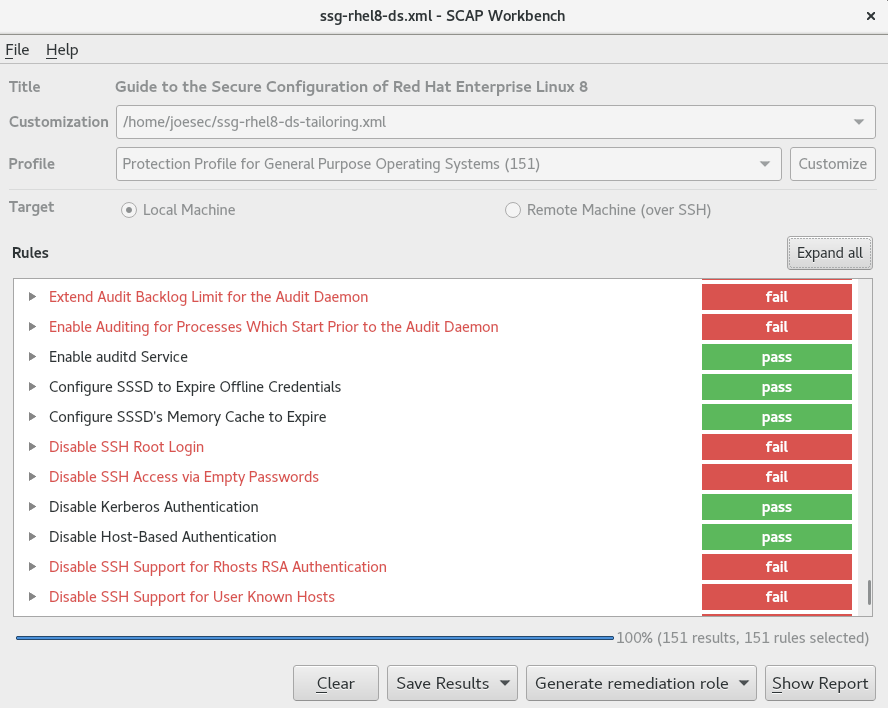

SCAP Workbench - O utilitário gráfico

scap-workbenché projetado para realizar varreduras de configuração e vulnerabilidade em um único sistema local ou remoto. Você também pode usá-lo para gerar relatórios de segurança com base nestas varreduras e avaliações. -

OpenSCAP - A biblioteca

OpenSCAP, com o utilitário de linha de comandooscap, foi projetada para realizar varreduras de configuração e vulnerabilidade em um sistema local, para validar o conteúdo de conformidade de configuração e para gerar relatórios e guias baseados nessas varreduras e avaliações. -

SCAP Security Guide (SSG) - O pacote

scap-security-guidefornece a mais recente coleção de políticas de segurança para sistemas Linux. A orientação consiste em um catálogo de conselhos práticos de endurecimento, ligados às exigências governamentais, quando aplicável. O projeto faz a ponte entre os requisitos de políticas generalizadas e diretrizes específicas de implementação. -

Script Check Engine (SCE) - O SCE é uma extensão do protocolo SCAP que permite aos administradores escrever seu conteúdo de segurança usando uma linguagem de script, como Bash, Python e Ruby. A extensão SCE é fornecida no pacote

openscap-engine-sce. O SCE em si não faz parte do padrão SCAP.

Para realizar auditorias de conformidade automatizadas em múltiplos sistemas remotamente, você pode usar a solução OpenSCAP para o Red Hat Satellite.

Recursos adicionais

-

oscap(8)- A página do manual do utilitário de linha de comandooscapfornece uma lista completa de opções disponíveis e explicações sobre seu uso. - Demonstrações de segurança da Red Hat: Criando Conteúdo de Política de Segurança Personalizada para Automatizar a Conformidade de Segurança - Um laboratório prático para obter experiência inicial na automatização da conformidade de segurança usando as ferramentas incluídas no Red Hat Enterprise Linux para cumprir tanto as políticas de segurança padrão da indústria quanto as políticas de segurança personalizadas. Se você deseja treinamento ou acesso a estes exercícios de laboratório para sua equipe, contate sua equipe de conta da Red Hat para obter detalhes adicionais.

- Demonstrações de segurança da Red Hat: Defenda-se com as Tecnologias de Segurança RHEL - Um laboratório prático para aprender como implementar segurança em todos os níveis de seu sistema RHEL, usando as principais tecnologias de segurança disponíveis no Red Hat Enterprise Linux, incluindo OpenSCAP. Se você deseja treinamento ou acesso a estes exercícios de laboratório para sua equipe, contate sua equipe de conta da Red Hat para obter detalhes adicionais.

-

scap-workbench(8)- A página do manual da aplicaçãoSCAP Workbenchfornece informações básicas sobre a aplicação, bem como alguns links para fontes potenciais de conteúdo SCAP. -

scap-security-guide(8)- A página do manual do projetoscap-security-guidefornece mais documentação sobre os vários perfis de segurança SCAP disponíveis. São fornecidos também exemplos de como utilizar as referências fornecidas usando o utilitário OpenSCAP. - Para mais detalhes sobre o uso do OpenSCAP com o Red Hat Satellite, veja Gerenciamento de Conformidade de Segurança no Guia de Administração do Red Hat Satellite.

6.2. Varredura de vulnerabilidades

6.2.1. Red Hat Security Advisories Alimentação OVAL

Os recursos de auditoria de segurança do Red Hat Enterprise Linux são baseados no padrão Security Content Automation Protocol (SCAP). O SCAP é uma estrutura multiuso de especificações que suporta configuração automatizada, verificação de vulnerabilidade e patch, atividades de conformidade de controle técnico e medição de segurança.