Red Hat Training

A Red Hat training course is available for RHEL 8

Monitoramento e gerenciamento do status e desempenho do sistema

Otimização do rendimento, da latência e do consumo de energia do sistema

Resumo

Tornando o código aberto mais inclusivo

A Red Hat tem o compromisso de substituir a linguagem problemática em nosso código, documentação e propriedades da web. Estamos começando com estes quatro termos: master, slave, blacklist e whitelist. Por causa da enormidade deste esforço, estas mudanças serão implementadas gradualmente ao longo de vários lançamentos futuros. Para mais detalhes, veja a mensagem de nosso CTO Chris Wright.

Fornecendo feedback sobre a documentação da Red Hat

Agradecemos sua contribuição em nossa documentação. Por favor, diga-nos como podemos melhorá-la. Para fazer isso:

Para comentários simples sobre passagens específicas:

- Certifique-se de que você está visualizando a documentação no formato Multi-page HTML. Além disso, certifique-se de ver o botão Feedback no canto superior direito do documento.

- Use o cursor do mouse para destacar a parte do texto que você deseja comentar.

- Clique no pop-up Add Feedback que aparece abaixo do texto destacado.

- Siga as instruções apresentadas.

Para enviar comentários mais complexos, crie um bilhete Bugzilla:

- Ir para o site da Bugzilla.

- Como Componente, use Documentation.

- Preencha o campo Description com sua sugestão de melhoria. Inclua um link para a(s) parte(s) relevante(s) da documentação.

- Clique em Submit Bug.

Capítulo 1. Visão geral das opções de monitoramento de desempenho

A seguir estão algumas das ferramentas de monitoramento e configuração de desempenho disponíveis no Red Hat Enterprise Linux 8:

-

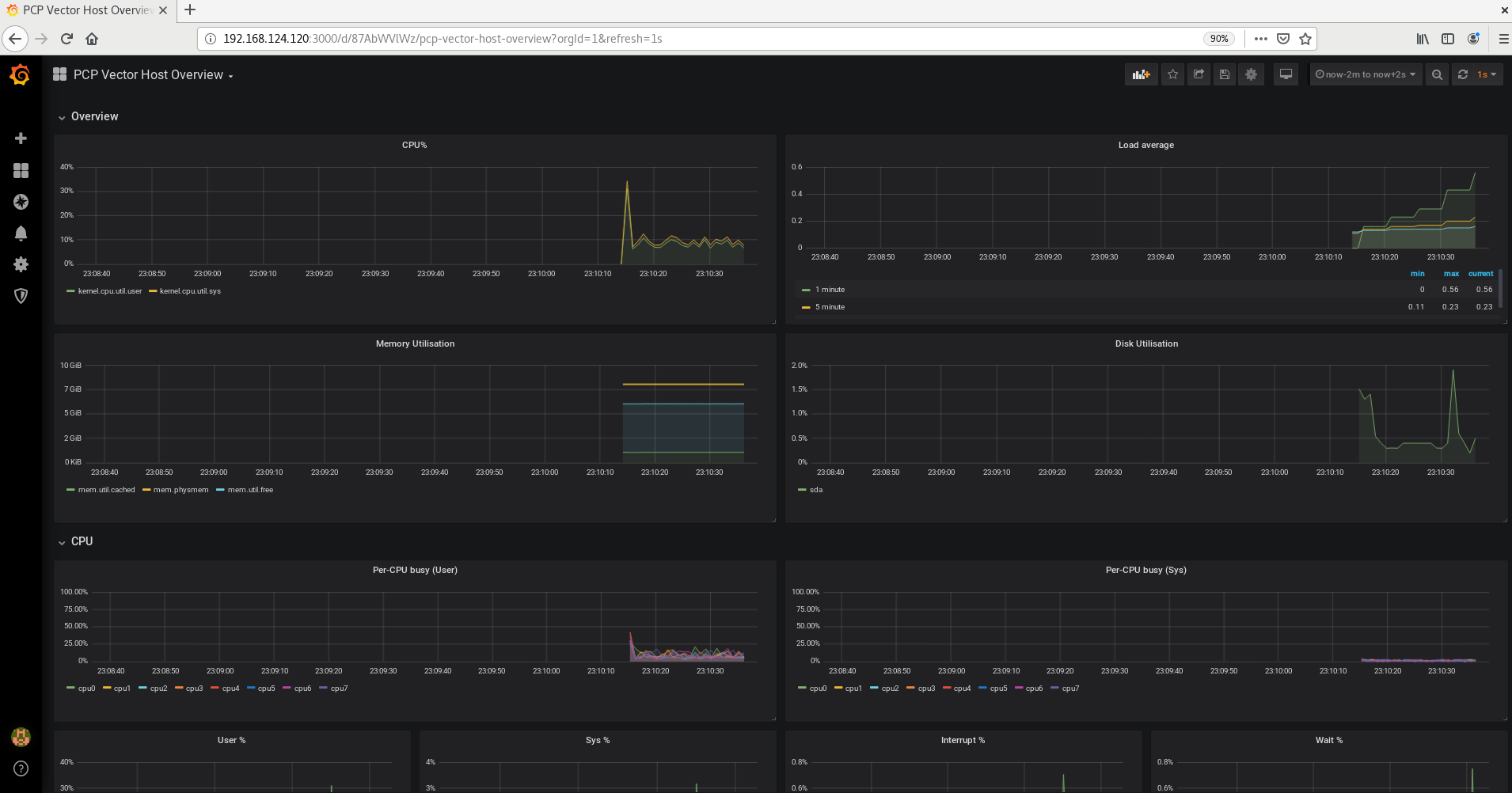

O Performance Co-Pilot (

pcp) é usado para monitorar, visualizar, armazenar e analisar as medições de desempenho em nível de sistema. Ele permite o monitoramento e gerenciamento de dados em tempo real, e o registro e recuperação de dados históricos. O Red Hat Enterprise Linux 8 fornece várias ferramentas que podem ser usadas da linha de comando para monitorar um sistema fora do nível de execução 5. A seguir estão as ferramentas da linha de comando embutidas:

-

topé fornecido pelo pacoteprocps-ng. Ele dá uma visão dinâmica dos processos em um sistema em execução. Ele exibe uma variedade de informações, incluindo um resumo do sistema e uma lista de tarefas atualmente sendo gerenciadas pelo kernel do Linux. -

psé fornecido pelo pacoteprocps-ng. Ele captura um instantâneo de um seleto grupo de processos ativos. Por padrão, o grupo examinado é limitado aos processos que são de propriedade do usuário atual e associados ao terminal onde o comandopsé executado. -

As estatísticas da memória virtual (

vmstat) são fornecidas pelo pacoteprocps-ng. Ele fornece relatórios instantâneos dos processos de seu sistema, memória, paginação, entrada/saída de blocos, interrupções e atividade da CPU. -

O relatório de atividades do sistema (

sar) é fornecido pelo pacotesysstat. Ele coleta e relata informações sobre a atividade do sistema que ocorreu até o momento no dia atual.

-

-

perfusa contadores de desempenho de hardware e pontos de rastreamento de kernel para rastrear o impacto de outros comandos e aplicações em um sistema. -

bcc-toolsé usado para a Coleção de Compiladores BPF (BCC). Ele fornece mais de 100 scriptseBPFque monitoram as atividades do kernel. Para mais informações sobre cada uma destas ferramentas, veja a página de manual descrevendo como utilizá-la e quais funções ela executa. -

turbostaté fornecido pelo pacotekernel-tools. Ele relata a topologia do processador, freqüência, estatísticas do estado de inatividade, temperatura e uso de energia nos processadores Intel 64. -

iostaté fornecido pelo pacotesysstat. Ele monitora e relata a carga do dispositivo de entrada/saída do sistema para ajudar os administradores a tomarem decisões sobre como equilibrar a carga de entrada/saída entre os discos físicos. -

irqbalancedistribui interrupções de hardware entre processadores para melhorar o desempenho do sistema. -

ssimprime informações estatísticas sobre soquetes, permitindo aos administradores avaliar o desempenho do dispositivo ao longo do tempo. A Red Hat recomenda o uso desssobrenetstatno Red Hat Enterprise Linux 8. -

numastaté fornecido pelo pacotenumactl. Por padrão,numastatexibe as estatísticas por nó NUMA de um sistema de falhas do alocador de memória do kernel. O desempenho ideal é indicado pelos valores altosnuma_hite baixosnuma_miss. -

numadé um daemon automático de gestão de afinidade NUMA. Ele monitora a topologia NUMA e o uso de recursos dentro de um sistema que melhora dinamicamente a alocação de recursos NUMA, o gerenciamento e, portanto, o desempenho do sistema. -

SystemTapmonitora e analisa as atividades do sistema operacional, especialmente as atividades do kernel. -

valgrindanalisa as aplicações executando-o em uma CPU sintética e instrumentando o código de aplicação existente à medida que é executado. Em seguida, imprime comentários que identificam claramente cada processo envolvido na execução da aplicação para um arquivo especificado pelo usuário, descritor de arquivo ou soquete de rede. Também é útil para encontrar vazamentos de memória. -

pqosé fornecido pelo pacoteintel-cmt-cat. Ele monitora e controla o cache da CPU e a largura de banda de memória em processadores Intel recentes.

Recursos adicionais

-

Para mais informações, consulte as páginas de homens de

pcp,top,ps,vmstat,sar,perf,iostat,irqbalance,ss,numastat,numad,valgrind, epqos. -

Para maiores informações em

pcp, veja a documentação no diretório/usr/share/doc/. -

Para mais informações sobre o valor

awaite o que pode fazer com que seus valores sejam altos, veja o artigo da Red Hat Knowledgebase: Qual é exatamente o significado do valor "esperar" relatado pelo iostat?

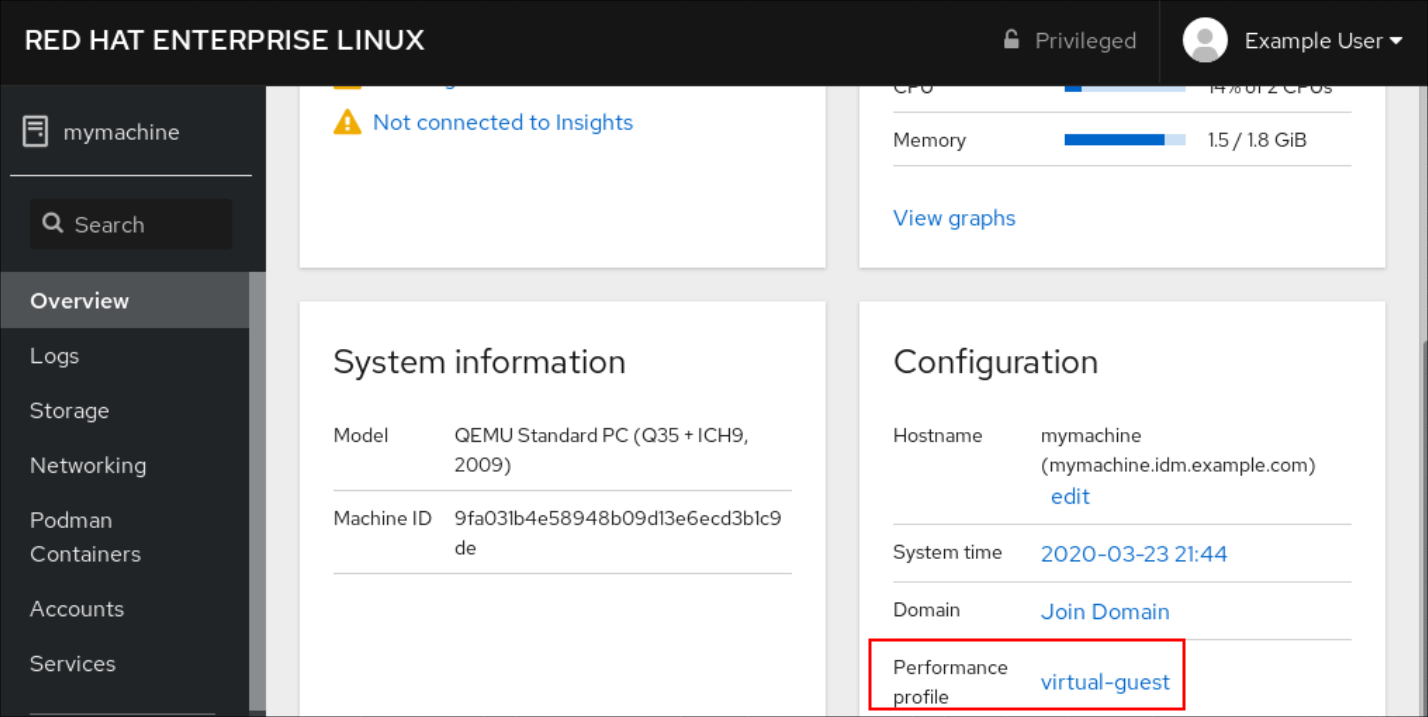

Capítulo 2. Começando com Tuned

Como administrador do sistema, você pode usar o aplicativo Tuned para otimizar o perfil de desempenho de seu sistema para uma variedade de casos de uso.

2.1. O propósito de Tuned

Tuned é um serviço que monitora seu sistema e otimiza o desempenho sob certas cargas de trabalho. O núcleo do Tuned é profiles, que afina seu sistema para diferentes casos de uso.

Tuned é distribuído com uma série de perfis pré-definidos para casos de uso, como por exemplo:

- Alto rendimento

- Baixa latência

- Economia de energia

É possível modificar as regras definidas para cada perfil e personalizar a afinação de um determinado dispositivo. Ao mudar para outro perfil ou desativar Tuned, todas as mudanças feitas nas configurações do sistema pelo perfil anterior retornam ao seu estado original.

Você também pode configurar Tuned para reagir às mudanças no uso do dispositivo e ajustar as configurações para melhorar o desempenho dos dispositivos ativos e reduzir o consumo de energia dos dispositivos inativos.

2.2. Perfis afinados

Uma análise detalhada de um sistema pode ser muito demorada. Tuned fornece uma série de perfis pré-definidos para casos de uso típico. Você também pode criar, modificar e excluir perfis.

Os perfis fornecidos com Tuned estão divididos nas seguintes categorias:

- Perfis de economia de energia

- Perfis de aumento de desempenho

Os perfis de aumento de desempenho incluem perfis que se concentram nos seguintes aspectos:

- Baixa latência para armazenamento e rede

- Alto rendimento para armazenamento e rede

- Desempenho da máquina virtual

- Desempenho do host de virtualização

O perfil padrão

Durante a instalação, o melhor perfil para seu sistema é selecionado automaticamente. Atualmente, o perfil padrão é selecionado de acordo com as seguintes regras personalizáveis:

| Meio Ambiente | Perfil padrão | Objetivo |

|---|---|---|

| Nós de cálculo |

| O melhor desempenho em termos de rendimento |

| Máquinas virtuais |

|

O melhor desempenho. Se você não estiver interessado no melhor desempenho, você pode mudá-lo para o perfil |

| Outros casos |

| Desempenho equilibrado e consumo de energia |

Perfis fundidos

Como uma característica experimental, é possível selecionar mais perfis de uma vez. Tuned tentará fundi-los durante a carga.

Se houver conflitos, as configurações do último perfil especificado têm precedência.

Exemplo 2.1. Baixo consumo de energia em um convidado virtual

O exemplo a seguir otimiza o sistema para funcionar em uma máquina virtual para o melhor desempenho e, ao mesmo tempo, sintoniza-o para baixo consumo de energia, enquanto o baixo consumo de energia é a prioridade:

# Perfil do convidado virtual de perfil afinado powersave

A fusão é feita automaticamente sem verificar se a combinação de parâmetros resultante faz sentido. Conseqüentemente, a característica pode afinar alguns parâmetros da maneira oposta, o que pode ser contraproducente: por exemplo, ajustando o disco para alta produção usando o perfil throughput-performance e, simultaneamente, ajustando o spindown do disco para o valor baixo pelo perfil spindown-disk.

A localização dos perfis

Tuned armazena perfis nos seguintes diretórios:

/usr/lib/tuned/-

Os perfis específicos de distribuição são armazenados no diretório. Cada perfil tem seu próprio diretório. O perfil consiste no arquivo principal de configuração chamado

tuned.conf, e opcionalmente outros arquivos, por exemplo, scripts de ajuda. /etc/tuned/-

Se você precisar personalizar um perfil, copie o diretório de perfis para o diretório, que é usado para perfis personalizados. Se houver dois perfis com o mesmo nome, é usado o perfil personalizado localizado em

/etc/tuned/.

A sintaxe da configuração do perfil

O arquivo tuned.conf pode conter uma seção [main] e outras seções para a configuração de instâncias de plug-in. Entretanto, todas as seções são opcionais.

As linhas que começam com o sinal de hash (#) são comentários.

Recursos adicionais

-

A página do homem

tuned.conf(5).

2.3. Perfis afinados distribuídos com a RHEL

A seguir está uma lista de perfis que estão instalados com Tuned no Red Hat Enterprise Linux.

Pode haver mais perfis de produtos específicos ou de terceiros Tuned disponíveis. Tais perfis são normalmente fornecidos por pacotes de RPM separados.

balanced-

O perfil padrão de economia de energia. Pretende-se que seja um compromisso entre desempenho e consumo de energia. Utiliza o autoescalonamento e o autoajuste sempre que possível. O único inconveniente é o aumento da latência. No atual lançamento Tuned, ele habilita a CPU, disco, áudio e plugins de vídeo, e ativa o governador da CPU

conservative. A opçãoradeon_powersaveusa o valordpm-balancedse for suportado, caso contrário, está configurada paraauto. powersaveUm perfil para o máximo desempenho de economia de energia. Ele pode acelerar o desempenho a fim de minimizar o consumo real de energia. No atual lançamento Tuned, ele permite autosuspendência USB, economia de energia WiFi e economia de energia de Link Power Management (ALPM) agressivo para adaptadores host SATA. Ele também programa economia de energia para sistemas com uma baixa taxa de despertar e ativa o regulador

ondemand. Ele permite economia de energia de áudio AC97 ou, dependendo de seu sistema, economia de energia HDA-Intel com um timeout de 10 segundos. Se seu sistema contém uma placa gráfica Radeon suportada com KMS habilitado, o perfil a configura para economia automática de energia. Nos PCs ASUS Eee, um Motor Super Híbrido dinâmico é habilitado.NotaEm certos casos, o perfil

balancedé mais eficiente em comparação com o perfilpowersave.Considere que há uma quantidade definida de trabalho que precisa ser feita, por exemplo, um arquivo de vídeo que precisa ser transcodificado. Sua máquina pode consumir menos energia se a transcodificação for feita na potência total, porque a tarefa é concluída rapidamente, a máquina começa a ficar ociosa, e pode automaticamente descer para modos de economia de energia muito eficientes. Por outro lado, se você transcodificar o arquivo com uma máquina estrangulada, a máquina consome menos energia durante a transcodificação, mas o processo leva mais tempo e a energia total consumida pode ser maior.

É por isso que o perfil

balancedpode ser geralmente uma opção melhor.throughput-performance-

Um perfil de servidor otimizado para alta taxa de transferência. Ele desabilita mecanismos de economia de energia e permite configurações do

sysctlque melhoram o desempenho de rendimento do disco e do IO da rede. O regulador de CPU está configurado paraperformance. latency-performance-

Um perfil de servidor otimizado para baixa latência. Ele desativa os mecanismos de economia de energia e permite a configuração do

sysctlque melhora a latência. O governador da CPU está configurado paraperformancee a CPU está bloqueada para os estados de baixa C (por PM QoS). network-latency-

Um perfil para ajuste de rede de baixa latência. Ele se baseia no perfil

latency-performance. Além disso, desativa o balanceamento de páginas enormes transparentes e NUMA, e ajusta vários outros parâmetrossysctlrelacionados à rede. network-throughput-

Um perfil para a sintonia da rede de produção. Ele se baseia no perfil

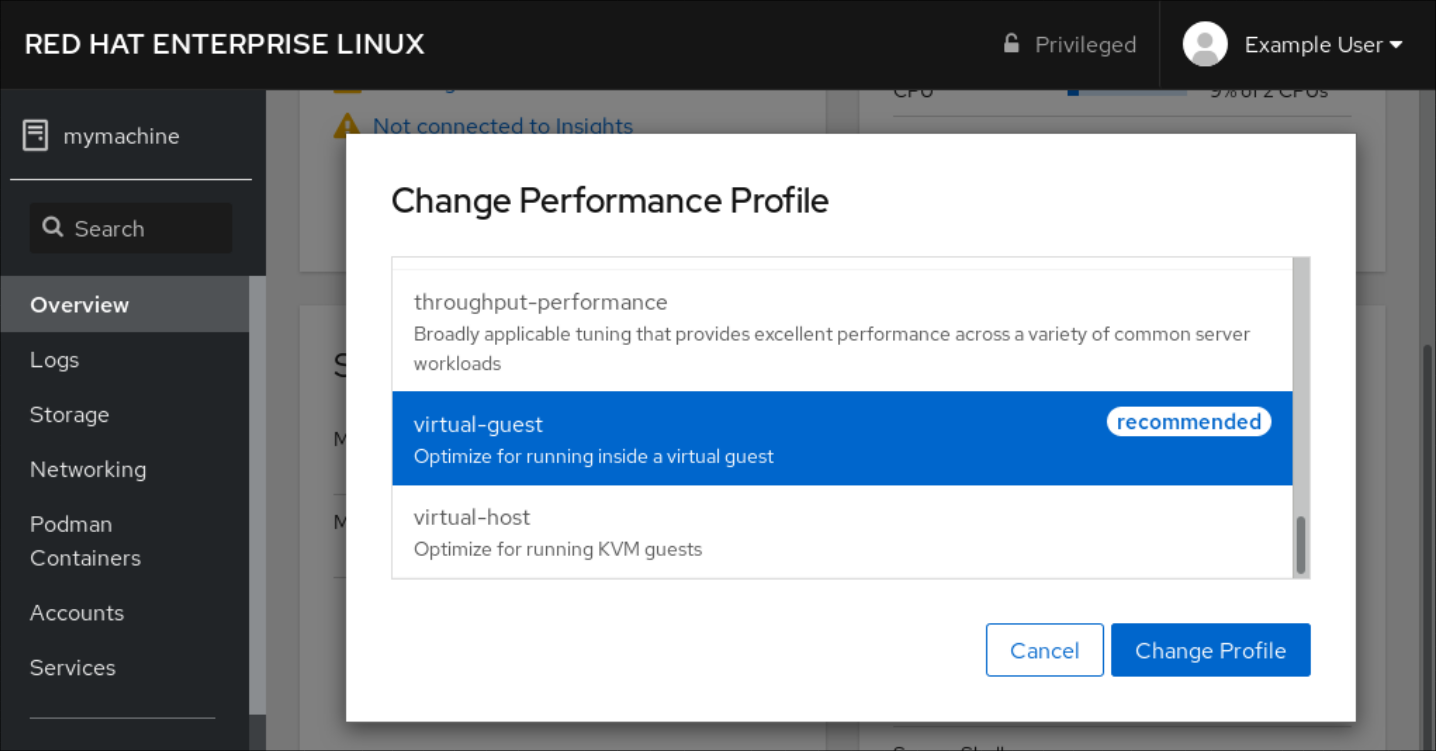

throughput-performance. Além disso, aumenta os buffers de rede do kernel. virtual-guest-

Um perfil projetado para máquinas virtuais Red Hat Enterprise Linux 8 e convidados VMWare com base no perfil

throughput-performanceque, entre outras tarefas, diminui a troca de memória virtual e aumenta os valores de readahead de disco. Ele não desabilita as barreiras de disco. virtual-host-

Um perfil projetado para hosts virtuais com base no perfil

throughput-performanceque, entre outras tarefas, diminui a troca de memória virtual, aumenta os valores de readahead de disco e permite um valor mais agressivo de writeback de páginas sujas. oracle-

Um perfil otimizado para cargas de bancos de dados Oracle baseado no perfil

throughput-performance. Além disso, ele desativa páginas enormes transparentes e modifica outros parâmetros do kernel relacionados ao desempenho. Este perfil é fornecido pelo pacotetuned-profiles-oracle. desktop-

Um perfil otimizado para desktops, com base no perfil

balanced. Além disso, permite a criação de autogrupos programados para uma melhor resposta das aplicações interativas. cpu-partitioningO perfil

cpu-partitioningsepara as CPUs do sistema em CPUs isoladas e domésticas. Para reduzir o jitter e as interrupções em uma CPU isolada, o perfil limpa a CPU isolada dos processos de espaço do usuário, dos fios móveis do kernel, dos manipuladores de interrupção e dos temporizadores do kernel.Uma CPU de manutenção doméstica pode executar todos os serviços, processos shell e fios de kernel.

Você pode configurar o perfil

cpu-partitioningno arquivo/etc/tuned/cpu-partitioning-variables.conf. As opções de configuração são:isolated_cores=cpu-list-

Lista CPUs a serem isoladas. A lista de CPUs isoladas é separada por vírgulas ou o usuário pode especificar o intervalo. É possível especificar um intervalo usando um traço, como por exemplo

3-5. Esta opção é obrigatória. Qualquer CPU em falta nesta lista é automaticamente considerada uma CPU doméstica. no_balance_cores=cpu-list-

Lista as CPUs que não são consideradas pelo núcleo durante o balanceamento de carga do processo em todo o sistema. Esta opção é opcional. Esta é normalmente a mesma lista que a

isolated_cores.

Para mais informações em

cpu-partitioning, consulte a página de manualtuned-profiles-cpu-partitioning(7).postgresql-

Um perfil otimizado para cargas de bancos de dados PostgreSQL baseado no perfil

throughput-performance. Além disso, ele desativa páginas enormes transparentes e modifica outros parâmetros do kernel relacionados ao desempenho. Este perfil é fornecido pelo pacotetuned-profiles-postgresql.

Perfis em tempo real

Os perfis em tempo real são destinados a sistemas que executam o núcleo em tempo real. Sem uma construção especial do kernel, eles não configuram o sistema para ser em tempo real. Na RHEL, os perfis estão disponíveis a partir de repositórios adicionais.

Os seguintes perfis em tempo real estão disponíveis:

realtimeUtilização em sistemas de tempo real de metais nulos.

Fornecido pelo pacote

tuned-profiles-realtime, que está disponível a partir dos repositórios RT ou NFV.realtime-virtual-hostUtilização em um host de virtualização configurado para tempo real.

Fornecido pelo pacote

tuned-profiles-nfv-host, que está disponível no repositório da NFV.realtime-virtual-guestUtilização em um convidado de virtualização configurado para tempo real.

Fornecido pelo pacote

tuned-profiles-nfv-guest, que está disponível no repositório da NFV.

2.4. Sintonia estática e dinâmica em Tuned

Esta seção explica a diferença entre as duas categorias de ajuste de sistemas que se aplicam a Tuned: static e dynamic.

- Sintonia estática

-

Consiste principalmente na aplicação de configurações predefinidas de

sysctlesysfse na ativação de várias ferramentas de configuração, comoethtool. - Sintonia dinâmica

Observa como vários componentes do sistema são usados durante o tempo de funcionamento de seu sistema. Tuned ajusta as configurações do sistema dinamicamente com base nessas informações de monitoramento.

Por exemplo, o disco rígido é muito usado durante a inicialização e o login, mas mal é usado mais tarde quando o usuário pode trabalhar principalmente com aplicações como navegadores web ou clientes de e-mail. Da mesma forma, a CPU e os dispositivos de rede são usados de forma diferente em momentos diferentes. Tuned monitora a atividade destes componentes e reage às mudanças em seu uso.

Por padrão, a sintonia dinâmica está desativada. Para ativá-la, edite o arquivo

/etc/tuned/tuned-main.confe mude a opçãodynamic_tuningpara1. Tuned então periodicamente analisa as estatísticas do sistema e as utiliza para atualizar suas configurações de ajuste do sistema. Para configurar o intervalo de tempo em segundos entre estas atualizações, use a opçãoupdate_interval.Os algoritmos de ajuste dinâmico atualmente implementados tentam equilibrar o desempenho e o poder de corte, e por isso são desativados nos perfis de desempenho. O ajuste dinâmico para plug-ins individuais pode ser habilitado ou desabilitado nos perfis Tuned.

Exemplo 2.2. Sintonia estática e dinâmica em uma estação de trabalho

Em uma estação de trabalho típica do escritório, a interface de rede Ethernet está inativa a maior parte do tempo. Apenas alguns poucos e-mails entram e saem ou algumas páginas da web podem ser carregadas.

Para esses tipos de cargas, a interface de rede não precisa funcionar a toda velocidade o tempo todo, como faz por padrão. Tuned tem um plug-in de monitoramento e ajuste para dispositivos de rede que podem detectar essa baixa atividade e depois baixar automaticamente a velocidade dessa interface, resultando normalmente em um menor consumo de energia.

Se a atividade na interface aumenta por um período de tempo maior, por exemplo, porque uma imagem de DVD está sendo baixada ou um e-mail com um anexo grande é aberto, Tuned detecta isso e define a velocidade máxima da interface para oferecer o melhor desempenho enquanto o nível de atividade é alto.

Este princípio é usado para outros plug-ins para CPU e discos também.

2.5. Modo sintonizado sem demônio

Você pode rodar Tuned no modo no-daemon, que não requer nenhuma memória residente. Neste modo, Tuned aplica as configurações e as saídas.

Por padrão, o modo no-daemon está desativado porque falta muita funcionalidade Tuned neste modo, inclusive:

- Apoio D-Bus

- Suporte a hot-plug

- Suporte Rollback para configurações

Para ativar o modo no-daemon, inclua a seguinte linha no arquivo /etc/tuned/tuned-main.conf:

daemon = 0

2.6. Instalando e habilitando o Tuned

Este procedimento instala e habilita o aplicativo Tuned, instala perfis Tuned e pré-define um perfil padrão Tuned para seu sistema.

Procedimento

Instale o pacote

tuned:# yum instalar afinado

Habilite e inicie o serviço

tuned:# systemctl habilitado --agora sintonizado

Opcionalmente, instale os perfis Tuned para sistemas em tempo real:

# yum instalar perfis sintonizados - perfis sintonizados em tempo real-nfv

Verificar se um perfil Tuned está ativo e aplicado:

$ tuned-adm active Current active profile: balanced$ tuned-adm verify Verfication succeeded, current system settings match the preset profile. See tuned log file ('/var/log/tuned/tuned.log') for details.

2.7. Listagem de perfis afinados disponíveis

Este procedimento lista todos os perfis Tuned que estão atualmente disponíveis em seu sistema.

Procedimento

Para listar todos os perfis disponíveis Tuned em seu sistema, use:

$ tuned-adm list Available profiles: - balanced - General non-specialized tuned profile - desktop - Optimize for the desktop use-case - latency-performance - Optimize for deterministic performance at the cost of increased power consumption - network-latency - Optimize for deterministic performance at the cost of increased power consumption, focused on low latency network performance - network-throughput - Optimize for streaming network throughput, generally only necessary on older CPUs or 40G+ networks - powersave - Optimize for low power consumption - throughput-performance - Broadly applicable tuning that provides excellent performance across a variety of common server workloads - virtual-guest - Optimize for running inside a virtual guest - virtual-host - Optimize for running KVM guests Current active profile: balanced

Para exibir apenas o perfil atualmente ativo, use:

$ tuned-adm active Current active profile: balanced

Recursos adicionais

-

A página do homem

tuned-adm(8).

2.8. Definição de um perfil afinado

Este procedimento ativa um perfil Tuned selecionado em seu sistema.

Pré-requisitos

-

O serviço

tunedestá funcionando. Veja Seção 2.6, “Instalando e habilitando o Tuned” para detalhes.

Procedimento

Opcionalmente, você pode deixar Tuned recomendar o perfil mais adequado para seu sistema:

# tuned-adm recommend balancedAtivar um perfil:

# perfil afinado-adm selected-profileAlternativamente, você pode ativar uma combinação de vários perfis:

# perfil afinado-adm profile1 profile2

Exemplo 2.3. Uma máquina virtual otimizada para baixo consumo de energia

O exemplo a seguir otimiza o sistema para funcionar em uma máquina virtual com o melhor desempenho e, ao mesmo tempo, o afina para um baixo consumo de energia, enquanto o baixo consumo de energia é a prioridade:

# Perfil do convidado virtual de perfil afinado powersave

Veja o perfil atual ativo Tuned em seu sistema:

# tuned-adm active Current active profile: selected-profileReinicie o sistema:

# reinicialização

Etapas de verificação

Verifique se o perfil Tuned está ativo e aplicado:

$ tuned-adm verify Verfication succeeded, current system settings match the preset profile. See tuned log file ('/var/log/tuned/tuned.log') for details.

Recursos adicionais

-

A página do homem

tuned-adm(8)

2.9. Desabilitando Tuned

Este procedimento desativa Tuned e redefine todas as configurações do sistema afetado para seu estado original antes de Tuned modificá-las.

Procedimento

Para desativar todas as afinações temporariamente:

# tuned-adm off

As afinações são aplicadas novamente após o reinício do serviço

tuned.Alternativamente, para parar e desativar o serviço

tunedpermanentemente:# systemctl desativar --agora sintonizado

Recursos adicionais

-

A página do homem

tuned-adm(8).

2.10. Informações relacionadas

-

A página do homem

tuned(8) -

A página do homem

tuned-adm(8) - O site do projeto Tuned: https://tuned-project.org/

Capítulo 3. Personalização de perfis afinados

Você pode criar ou modificar os perfis Tuned para otimizar o desempenho do sistema para seu caso de uso pretendido.

Pré-requisitos

- Instalar e habilitar Tuned como descrito em Seção 2.6, “Instalando e habilitando o Tuned”.

3.1. Perfis afinados

Uma análise detalhada de um sistema pode ser muito demorada. Tuned fornece uma série de perfis pré-definidos para casos de uso típico. Você também pode criar, modificar e excluir perfis.

Os perfis fornecidos com Tuned estão divididos nas seguintes categorias:

- Perfis de economia de energia

- Perfis de aumento de desempenho

Os perfis de aumento de desempenho incluem perfis que se concentram nos seguintes aspectos:

- Baixa latência para armazenamento e rede

- Alto rendimento para armazenamento e rede

- Desempenho da máquina virtual

- Desempenho do host de virtualização

O perfil padrão

Durante a instalação, o melhor perfil para seu sistema é selecionado automaticamente. Atualmente, o perfil padrão é selecionado de acordo com as seguintes regras personalizáveis:

| Meio Ambiente | Perfil padrão | Objetivo |

|---|---|---|

| Nós de cálculo |

| O melhor desempenho em termos de rendimento |

| Máquinas virtuais |

|

O melhor desempenho. Se você não estiver interessado no melhor desempenho, você pode mudá-lo para o perfil |

| Outros casos |

| Desempenho equilibrado e consumo de energia |

Perfis fundidos

Como uma característica experimental, é possível selecionar mais perfis de uma vez. Tuned tentará fundi-los durante a carga.

Se houver conflitos, as configurações do último perfil especificado têm precedência.

Exemplo 3.1. Baixo consumo de energia em um convidado virtual

O exemplo a seguir otimiza o sistema para funcionar em uma máquina virtual para o melhor desempenho e, ao mesmo tempo, sintoniza-o para baixo consumo de energia, enquanto o baixo consumo de energia é a prioridade:

# Perfil do convidado virtual de perfil afinado powersave

A fusão é feita automaticamente sem verificar se a combinação de parâmetros resultante faz sentido. Conseqüentemente, a característica pode afinar alguns parâmetros da maneira oposta, o que pode ser contraproducente: por exemplo, ajustando o disco para alta produção usando o perfil throughput-performance e, simultaneamente, ajustando o spindown do disco para o valor baixo pelo perfil spindown-disk.

A localização dos perfis

Tuned armazena perfis nos seguintes diretórios:

/usr/lib/tuned/-

Os perfis específicos de distribuição são armazenados no diretório. Cada perfil tem seu próprio diretório. O perfil consiste no arquivo principal de configuração chamado

tuned.conf, e opcionalmente outros arquivos, por exemplo, scripts de ajuda. /etc/tuned/-

Se você precisar personalizar um perfil, copie o diretório de perfis para o diretório, que é usado para perfis personalizados. Se houver dois perfis com o mesmo nome, é usado o perfil personalizado localizado em

/etc/tuned/.

A sintaxe da configuração do perfil

O arquivo tuned.conf pode conter uma seção [main] e outras seções para a configuração de instâncias de plug-in. Entretanto, todas as seções são opcionais.

As linhas que começam com o sinal de hash (#) são comentários.

Recursos adicionais

-

A página do homem

tuned.conf(5).

3.2. Herança entre perfis afinados

Tuned os perfis podem ser baseados em outros perfis e modificar apenas certos aspectos de seu perfil pai.

A seção [main] de Tuned perfis reconhece a opção include:

[main]

include=parentTodas as configurações do parent são carregados neste perfil child. Nas seções seguintes, o perfil child pode substituir certas configurações herdadas do parent perfil ou adicionar novas configurações não presentes no parent perfil.

Você pode criar seu próprio perfil child no diretório /etc/tuned/ com base em um perfil pré-instalado em /usr/lib/tuned/ com apenas alguns parâmetros ajustados.

Se o parent perfil é atualizado, tal como após uma atualização em Tuned, as mudanças são refletidas no perfil child.

Exemplo 3.2. Um perfil de economia de energia baseado em

A seguir, um exemplo de um perfil personalizado que estende o perfil balanced e define o Aggressive Link Power Management (ALPM) para todos os dispositivos até a máxima economia de energia.

[main] include=balanced [scsi_host] alpm=min_power

Recursos adicionais

-

A página do homem

tuned.conf(5)

3.3. Sintonia estática e dinâmica em Tuned

Esta seção explica a diferença entre as duas categorias de ajuste de sistemas que se aplicam a Tuned: static e dynamic.

- Sintonia estática

-

Consiste principalmente na aplicação de configurações predefinidas de

sysctlesysfse na ativação de várias ferramentas de configuração, comoethtool. - Sintonia dinâmica

Observa como vários componentes do sistema são usados durante o tempo de funcionamento de seu sistema. Tuned ajusta as configurações do sistema dinamicamente com base nessas informações de monitoramento.

Por exemplo, o disco rígido é muito usado durante a inicialização e o login, mas mal é usado mais tarde quando o usuário pode trabalhar principalmente com aplicações como navegadores web ou clientes de e-mail. Da mesma forma, a CPU e os dispositivos de rede são usados de forma diferente em momentos diferentes. Tuned monitora a atividade destes componentes e reage às mudanças em seu uso.

Por padrão, a sintonia dinâmica está desativada. Para ativá-la, edite o arquivo

/etc/tuned/tuned-main.confe mude a opçãodynamic_tuningpara1. Tuned então periodicamente analisa as estatísticas do sistema e as utiliza para atualizar suas configurações de ajuste do sistema. Para configurar o intervalo de tempo em segundos entre estas atualizações, use a opçãoupdate_interval.Os algoritmos de ajuste dinâmico atualmente implementados tentam equilibrar o desempenho e o poder de corte, e por isso são desativados nos perfis de desempenho. O ajuste dinâmico para plug-ins individuais pode ser habilitado ou desabilitado nos perfis Tuned.

Exemplo 3.3. Sintonia estática e dinâmica em uma estação de trabalho

Em uma estação de trabalho típica do escritório, a interface de rede Ethernet está inativa a maior parte do tempo. Apenas alguns poucos e-mails entram e saem ou algumas páginas da web podem ser carregadas.

Para esses tipos de cargas, a interface de rede não precisa funcionar a toda velocidade o tempo todo, como faz por padrão. Tuned tem um plug-in de monitoramento e ajuste para dispositivos de rede que podem detectar essa baixa atividade e depois baixar automaticamente a velocidade dessa interface, resultando normalmente em um menor consumo de energia.

Se a atividade na interface aumenta por um período de tempo maior, por exemplo, porque uma imagem de DVD está sendo baixada ou um e-mail com um anexo grande é aberto, Tuned detecta isso e define a velocidade máxima da interface para oferecer o melhor desempenho enquanto o nível de atividade é alto.

Este princípio é usado para outros plug-ins para CPU e discos também.

3.4. Plug-ins afinados

Os plug-ins são módulos em perfis Tuned que Tuned usa para monitorar ou otimizar diferentes dispositivos no sistema.

Tuned utiliza dois tipos de plug-ins:

- plug-ins de monitoramento

- plug-ins de afinação

Plug-ins de monitoramento

Os plug-ins de monitoramento são usados para obter informações de um sistema em funcionamento. A saída dos plug-ins de monitoramento pode ser usada sintonizando os plug-ins para o ajuste dinâmico.

Os plug-ins de monitoramento são automaticamente instanciados sempre que suas métricas são necessárias por qualquer um dos plug-ins de ajuste habilitados. Se dois plug-ins de ajuste requerem os mesmos dados, apenas uma instância do plug-in de monitoramento é criada e os dados são compartilhados.

Plug-ins de afinação

Cada plug-in de sintonia sintoniza um subsistema individual e toma vários parâmetros que são povoados a partir dos perfis sintonizados. Cada subsistema pode ter vários dispositivos, tais como CPUs múltiplas ou placas de rede, que são tratados por instâncias individuais dos plug-ins de sintonização. Configurações específicas para dispositivos individuais também são suportadas.

Sintaxe para plug-ins em perfis afinados

As seções que descrevem as instâncias de plug-in são formatadas da seguinte forma:

[NAME] type=TYPE devices=DEVICES

- NOME

- é o nome da instância de plug-in como é usada nos logs. Pode ser uma cadeia arbitrária.

- TIPO

- é o tipo do plug-in de sintonia.

- DISPOSITIVOS

é a lista de dispositivos que esta instância de plug-in manipula.

A linha

devicespode conter uma lista, um wildcard (*), e negação (!). Se não houver uma linhadevices, todos os dispositivos presentes ou posteriormente anexados no sistema do TYPE são tratados pela instância de plug-in. Isto é o mesmo que usar a opçãodevices=*.Exemplo 3.4. Dispositivos de blocos de encaixe com um plug-in

O exemplo a seguir corresponde a todos os dispositivos de bloco que começam com

sd, comosdaousdb, e não desabilita as barreiras sobre eles:[data_disk] type=disk devices=sd* disable_barriers=false

O exemplo a seguir corresponde a todos os dispositivos de bloco, exceto

sda1esda2:[data_disk] type=disk devices=!sda1, !sda2 disable_barriers=false

Se nenhuma instância de um plug-in for especificada, o plug-in não é ativado.

Se o plug-in suportar mais opções, elas também podem ser especificadas na seção plug-in. Se a opção não for especificada e não tiver sido previamente especificada no plug-in incluído, o valor padrão é usado.

Sintaxe curta do plug-in

Se você não precisar de nomes personalizados para a instância plug-in e houver apenas uma definição da instância em seu arquivo de configuração, Tuned suporta a seguinte sintaxe curta:

[TYPE] devices=DEVICES

Neste caso, é possível omitir a linha type. A instância é então referenciada com um nome, igual ao tipo. O exemplo anterior poderia então ser reescrito:

Exemplo 3.5. Dispositivos de blocos de correspondência usando a sintaxe curta

[disk] devices=sdb* disable_barriers=false

Definições conflitantes de plug-in em um perfil

Se a mesma seção for especificada mais de uma vez usando a opção include, as configurações são fundidas. Se não puderem ser fundidas devido a um conflito, a última definição conflitante se sobrepõe às definições anteriores. Se você não souber o que foi definido anteriormente, você pode usar a opção replace Boolean e defini-la para true. Isto faz com que todas as definições anteriores com o mesmo nome sejam sobrescritas e a fusão não acontece.

Você também pode desativar o plug-in especificando a opção enabled=false. Isto tem o mesmo efeito como se a instância nunca tivesse sido definida. Desativar o plug-in é útil se você estiver redefinindo a definição anterior a partir da opção include e não quiser que o plug-in esteja ativo em seu perfil personalizado.

Funcionalidade não implementada em nenhum plug-in

Tuned inclui a capacidade de executar qualquer comando de shell como parte da habilitação ou desativação de um perfil de ajuste. Isto permite estender os perfis Tuned com funcionalidades que ainda não foram integradas no Tuned.

Você pode especificar comandos de shell arbitrários usando o plug-in script.

Recursos adicionais

-

A página do homem

tuned.conf(5)

3.5. Plug-ins afinados disponíveis

Esta seção lista todos os plug-ins de monitoramento e sintonia atualmente disponíveis em Tuned.

Plug-ins de monitoramento

Atualmente, são implementados os seguintes plug-ins de monitoramento:

disk- Obtém carga em disco (número de operações IO) por dispositivo e intervalo de medição.

net- Obtém carga de rede (número de pacotes transferidos) por placa de rede e intervalo de medição.

load- Obtém carga de CPU por CPU e intervalo de medição.

Plug-ins de afinação

Atualmente, são implementados os seguintes plug-ins de ajuste. Apenas alguns desses plug-ins implementam o ajuste dinâmico. As opções suportadas pelos plug-ins também são listadas:

cpuDefine o regulador da CPU para o valor especificado pela opção

governore muda dinamicamente a latência de Acesso Direto à Memória da CPU (DMA) da Qualidade de Serviço (PM QoS) de acordo com a carga da CPU.Se a carga da CPU for inferior ao valor especificado pela opção

load_threshold, a latência é definida para o valor especificado pela opçãolatency_high, caso contrário, é definida para o valor especificado porlatency_low.Você também pode forçar a latência a um valor específico e impedi-la de mudar dinamicamente ainda mais. Para fazer isso, defina a opção

force_latencypara o valor de latência necessário.eeepc_sheDefine dinamicamente a velocidade do barramento frontal (FSB) de acordo com a carga da CPU.

Esta característica pode ser encontrada em alguns netbooks e também é conhecida como o ASUS Super Hybrid Engine (SHE).

Se a carga da CPU for menor ou igual ao valor especificado pela opção

load_threshold_powersave, o plug-in define a velocidade da FSB para o valor especificado pela opçãoshe_powersave. Se a carga da CPU for maior ou igual ao valor especificado pela opçãoload_threshold_normal, ela define a velocidade FSB para o valor especificado pela opçãoshe_normal.O ajuste estático não é suportado e o plug-in é desabilitado de forma transparente se Tuned não detectar o suporte de hardware para este recurso.

net-

Configura a funcionalidade Wake-on-LAN para os valores especificados pela opção

wake_on_lan. Utiliza a mesma sintaxe que o utilitárioethtool. Também muda dinamicamente a velocidade da interface de acordo com a utilização da interface. sysctlDefine várias configurações

sysctlespecificadas pelas opções de plug-in.A sintaxe é

name=valueonde name é o mesmo que o nome fornecido pela concessionáriasysctl.Use o plug-in

sysctlse você precisar alterar as configurações do sistema que não são cobertas por outros plug-ins disponíveis em Tuned. Se as configurações forem cobertas por alguns plug-ins específicos, prefira estes plug-ins.usbDefine o timeout automático dos dispositivos USB para o valor especificado pelo parâmetro

autosuspend.O valor

0significa que o autosuspend é desativado.vmPermite ou desativa páginas enormes transparentes, dependendo do valor da opção

transparent_hugepages.Os valores válidos da opção

transparent_hugepagessão:- "sempre"..

- "nunca"..

- "madvise"

audioDefine o tempo limite autosuspendido para os codecs de áudio para o valor especificado pela opção

timeout.Atualmente, os codecs

snd_hda_intelesnd_ac97_codecsão suportados. O valor0significa que o autosuspend está desativado. Você também pode fazer com que o controlador seja reinicializado configurando a opção booleanareset_controllerparatrue.diskDefine o elevador de discos para o valor especificado pela opção

elevator.Também se define:

-

APM para o valor especificado pela opção

apm -

Escalonador quantum para o valor especificado pela opção

scheduler_quantum -

Tempo limite de spindown do disco para o valor especificado pela opção

spindown -

Disco readahead para o valor especificado pelo parâmetro

readahead -

O disco atual readahead a um valor multiplicado pela constante especificada pela opção

readahead_multiply

Além disso, este plug-in muda dinamicamente o gerenciamento avançado de energia e a configuração de spindown timeout para o acionamento de acordo com a utilização atual do acionamento. O ajuste dinâmico pode ser controlado pela opção Booleana

dynamice é ativado por padrão.-

APM para o valor especificado pela opção

scsi_hostOpções de sintonia para os anfitriões SCSI.

Estabelece o Aggressive Link Power Management (ALPM) para o valor especificado pela opção

alpm.mounts-

Ativa ou desativa barreiras para montagens de acordo com o valor booleano da opção

disable_barriers. scriptExecuta um script externo ou binário quando o perfil é carregado ou descarregado. Você pode escolher um executável arbitrário.

ImportanteO plug-in

scripté fornecido principalmente para compatibilidade com versões anteriores. Prefira outros plug-ins Tuned se eles cobrirem a funcionalidade necessária.Tuned chama o executável com um dos seguintes argumentos:

-

startao carregar o perfil -

stopao descarregar o perfil

Você precisa implementar corretamente a ação

stopem seu executável e reverter todas as configurações que você alterou durante a açãostart. Caso contrário, o passo de retrocesso após a mudança de seu perfil Tuned não funcionará.Os scripts Bash podem importar a biblioteca

/usr/lib/tuned/functionsBash e utilizar as funções aí definidas. Use estas funções somente para funcionalidades que não são fornecidas nativamente por Tuned. Se o nome de uma função começa com um sublinhado, como_wifi_set_power_level, considere a função privada e não a utilize em seus scripts, pois ela pode mudar no futuro.Especifique o caminho para o executável usando o parâmetro

scriptna configuração do plug-in.Exemplo 3.6. Executando um Bash script a partir de um perfil

Para executar um script Bash chamado

script.shque está localizado no diretório de perfis, use:[script] script=${i:PROFILE_DIR}/script.sh-

sysfsDefine várias configurações

sysfsespecificadas pelas opções de plug-in.A sintaxe é

name=valueonde name é o caminhosysfsa ser utilizado.Use este plug-in caso precise alterar algumas configurações que não são cobertas por outros plug-ins. Prefira plug-ins específicos se eles cobrirem as configurações necessárias.

videoEstabelece vários níveis de segurança de energia em placas de vídeo. Atualmente, somente os cartões Radeon são suportados.

O nível de powersave pode ser especificado usando a opção

radeon_powersave. Os valores suportados são:-

default -

auto -

low -

mid -

high -

dynpm -

dpm-battery -

dpm-balanced -

dpm-perfomance

Para obter detalhes, consulte www.x.org. Observe que este plug-in é experimental e a opção pode mudar em lançamentos futuros.

-

bootloaderAdiciona opções à linha de comando do kernel. Este plug-in suporta apenas o carregador de inicialização GRUB 2.

A localização personalizada não padrão do arquivo de configuração do GRUB 2 pode ser especificada pela opção

grub2_cfg_file.As opções do kernel são adicionadas à configuração atual do GRUB e seus modelos. O sistema precisa ser reinicializado para que as opções do kernel entrem em vigor.

A mudança para outro perfil ou a parada manual do serviço

tunedremove as opções adicionais. Se você desligar ou reinicializar o sistema, as opções do kernel persistem no arquivogrub.cfg.As opções de kernel podem ser especificadas pela seguinte sintaxe:

cmdline=arg1 arg2 .. argN

Exemplo 3.7. Modificando a linha de comando do kernel

Por exemplo, para adicionar a opção

quieta um perfil Tuned, inclua as seguintes linhas no arquivotuned.conf:[bootloader] cmdline=quiet

A seguir, um exemplo de um perfil personalizado que adiciona a opção

isolcpus=2à linha de comando do kernel:[bootloader] cmdline=isolcpus=2

3.6. Variáveis e funções incorporadas em perfis sintonizados

Variáveis e funções incorporadas se expandem em tempo de execução quando um perfil Tuned é ativado.

O uso das variáveis Tuned reduz a quantidade de digitação necessária nos perfis Tuned. Você também pode:

- Usar várias funções embutidas junto com variáveis Tuned

- Criar funções personalizadas em Python e adicioná-las a Tuned sob a forma de plug-ins

Variáveis

Não há variáveis pré-definidas nos perfis Tuned. Você pode definir suas próprias variáveis, criando a seção [variables] em um perfil e usando a seguinte sintaxe:

[variables] variable_name=value

Para expandir o valor de uma variável em um perfil, use a seguinte sintaxe:

${variable_name}Exemplo 3.8. Isolamento de núcleos de CPU usando variáveis

No exemplo a seguir, a variável ${isolated_cores} se expande para 1,2; daí as botas do kernel com a opção isolcpus=1,2:

[variables]

isolated_cores=1,2

[bootloader]

cmdline=isolcpus=${isolated_cores}

As variáveis podem ser especificadas em um arquivo separado. Por exemplo, você pode adicionar as seguintes linhas a tuned.conf:

[variables]

include=/etc/tuned/my-variables.conf

[bootloader]

cmdline=isolcpus=${isolated_cores}

Se você adicionar a opção isolated_cores=1,2 ao arquivo /etc/tuned/my-variables.conf, o kernel boots com a opção isolcpus=1,2.

Funções

Para chamar uma função, use a seguinte sintaxe:

${f:function_name:argument_1:argument_2}

Para expandir o caminho do diretório onde o perfil e o arquivo tuned.conf estão localizados, use a função PROFILE_DIR, que requer uma sintaxe especial:

${i:PROFILE_DIR}Exemplo 3.9. Isolamento de núcleos de CPU usando variáveis e funções incorporadas

No exemplo a seguir, a variável ${non_isolated_cores} se expande para 0,3-5, e a função embutida cpulist_invert é chamada com o argumento 0,3-5:

[variables]

non_isolated_cores=0,3-5

[bootloader]

cmdline=isolcpus=${f:cpulist_invert:${non_isolated_cores}}

A função cpulist_invert inverte a lista de CPUs. Para uma máquina com 6 CPUs, a inversão é 1,2, e a inicialização do kernel com a opção de linha de comando isolcpus=1,2.

Recursos adicionais

-

A página do homem

tuned.conf(5)

3.7. Funções incorporadas disponíveis em perfis afinados

As seguintes funções embutidas estão disponíveis em todos os perfis Tuned:

PROFILE_DIR-

Retorna o caminho do diretório onde o perfil e o arquivo

tuned.confestão localizados. exec- Executa um processo e devolve sua produção.

assertion- Compara dois argumentos. Se eles do not match, a função registra o texto do primeiro argumento e aborta o carregamento do perfil.

assertion_non_equal- Compara dois argumentos. Se eles match, a função registra o texto do primeiro argumento e aborta o carregamento do perfil.

kb2s- Converte kilobytes em setores de disco.

s2kb- Converte setores de disco em quilobytes.

strip- Cria um cordão a partir de todos os argumentos passados e elimina tanto o espaço branco de chumbo quanto o branco de fuga.

virt_checkVerifica se Tuned está funcionando dentro de uma máquina virtual (VM) ou em metal nu:

- Dentro de uma VM, a função retorna o primeiro argumento.

- No metal nu, a função retorna o segundo argumento, mesmo no caso de um erro.

cpulist_invert-

Inverte uma lista de CPUs para fazer seu complemento. Por exemplo, em um sistema com 4 CPUs, numeradas de 0 a 3, a inversão da lista

0,2,3é1. cpulist2hex- Converte uma lista de CPU para uma máscara de CPU hexadecimal.

cpulist2hex_invert- Converte uma lista de CPU para uma máscara de CPU hexadecimal e a inverte.

hex2cpulist- Converte uma máscara hexadecimal de CPU em uma lista de CPU.

cpulist_online- Verifica se as CPUs da lista estão online. Retorna a lista contendo apenas CPUs online.

cpulist_present- Verifica se as CPUs da lista estão presentes. Retorna a lista contendo apenas as CPUs presentes.

cpulist_unpack-

Desempacote uma lista de CPU na forma de

1-3,4para1,2,3,4. cpulist_pack-

Pacote uma lista de CPU na forma de

1,2,3,5para1-3,5.

3.8. Criação de novos perfis sintonizados

Este procedimento cria um novo perfil Tuned com regras de desempenho personalizadas.

Pré-requisitos

-

O serviço

tunedestá instalado e funcionando. Veja Seção 2.6, “Instalando e habilitando o Tuned” para detalhes.

Procedimento

No diretório

/etc/tuned/, crie um novo diretório com o mesmo nome que o perfil que você deseja criar:# mkdir /etc/tuned/my-profileNo novo diretório, crie um arquivo chamado

tuned.conf. Adicione uma seção[main]e definições de plug-in nela, de acordo com suas exigências.Por exemplo, veja a configuração do perfil

balanced:[main] summary=General non-specialized tuned profile [cpu] governor=conservative energy_perf_bias=normal [audio] timeout=10 [video] radeon_powersave=dpm-balanced, auto [scsi_host] alpm=medium_power

Para ativar o perfil, use:

# perfil afinado-adm my-profileVerificar se o perfil Tuned está ativo e se as configurações do sistema estão aplicadas:

$ tuned-adm active Current active profile: my-profile$ tuned-adm verify Verfication succeeded, current system settings match the preset profile. See tuned log file ('/var/log/tuned/tuned.log') for details.

Recursos adicionais

-

A página do homem

tuned.conf(5)

3.9. Modificação de perfis sintonizados existentes

Este procedimento cria um perfil infantil modificado com base em um perfil Tuned existente.

Pré-requisitos

-

O serviço

tunedestá instalado e funcionando. Veja Seção 2.6, “Instalando e habilitando o Tuned” para detalhes.

Procedimento

No diretório

/etc/tuned/, crie um novo diretório com o mesmo nome que o perfil que você deseja criar:# mkdir /etc/tuned/modified-profileNo novo diretório, crie um arquivo chamado

tuned.conf, e defina a seção[main]como segue:[main] include=parent-profileSubstitua parent-profile com o nome do perfil que você está modificando.

Inclua suas modificações de perfil.

Exemplo 3.10. Diminuindo a troca no perfil de desempenho de produção

Para usar as configurações do perfil

throughput-performancee alterar o valor devm.swappinesspara 5, em vez do valor padrão 10, use:[main] include=throughput-performance [sysctl] vm.swappiness=5

Para ativar o perfil, use:

# perfil afinado-adm modified-profileVerificar se o perfil Tuned está ativo e se as configurações do sistema estão aplicadas:

$ tuned-adm active Current active profile: my-profile$ tuned-adm verify Verfication succeeded, current system settings match the preset profile. See tuned log file ('/var/log/tuned/tuned.log') for details.

Recursos adicionais

-

A página do homem

tuned.conf(5)

3.10. Ajuste do programador de discos usando o Tuned

Este procedimento cria e permite um perfil Tuned que define um determinado programador de discos para os dispositivos de bloco selecionados. A configuração persiste através de reinicializações do sistema.

Nos seguintes comandos e configurações, substitua:

-

device com o nome do dispositivo do bloco, por exemplo

sdf -

selected-scheduler com o programador de discos que você deseja definir para o dispositivo, por exemplo

bfq

Pré-requisitos

O serviço

tunedestá instalado e habilitado.Para maiores detalhes, ver Seção 2.6, “Instalando e habilitando o Tuned”.

Procedimento

Opcional: Selecione um perfil existente em Tuned no qual seu perfil será baseado. Para uma lista dos perfis disponíveis, veja Seção 2.3, “Perfis afinados distribuídos com a RHEL”.

Para ver qual perfil está atualmente ativo, use:

$ tuned-adm ativo

Crie um novo diretório para manter seu perfil em Tuned:

# mkdir /etc/tuned/my-profileEncontre o identificador único do sistema do dispositivo de bloco selecionado:

$ udevadm info --query=property --name=/dev/device | grep -E '(WWN|SERIAL)' ID_WWN=0x5002538d00000000 ID_SERIAL=Generic-_SD_MMC_20120501030900000-0:0 ID_SERIAL_SHORT=20120501030900000

NotaO comando neste exemplo retornará todos os valores identificados como um World Wide Name (WWN) ou número de série associado ao dispositivo de bloco especificado. Embora seja preferível usar um WWN, o WWN nem sempre está disponível para um determinado dispositivo e quaisquer valores retornados pelo comando do exemplo são aceitáveis para uso como o device system unique ID.

Criar o

/etc/tuned/my-profile/tuned.confarquivo de configuração. No arquivo, defina as seguintes opções:Opcional: Incluir um perfil existente:

[main] include=existing-profileDefina o programador de disco selecionado para o dispositivo que corresponda ao identificador da WWN:

[disk] devices_udev_regex=IDNAME=device system unique id elevator=selected-scheduler

-

Substitua IDNAME com o nome do identificador a ser utilizado (por exemplo,

ID_WWN). -

Substitua device system unique id com o valor do identificador escolhido (por exemplo,

0x5002538d00000000).

Para combinar vários dispositivos na opção

devices_udev_regex, coloque os identificadores entre parênteses e separe-os com barras verticais:-

Substitua IDNAME com o nome do identificador a ser utilizado (por exemplo,

devices_udev_regex=(ID_WWN=0x5002538d00000000)|(ID_WWN=0x1234567800000000)

Habilite seu perfil:

# perfil afinado-adm my-profileVerificar se o perfil Sintonizado está ativo e aplicado:

$ tuned-adm active Current active profile: my-profile$ tuned-adm verify Verification succeeded, current system settings match the preset profile. See tuned log file ('/var/log/tuned/tuned.log') for details.

Recursos adicionais

- Para mais informações sobre como criar um perfil em Tuned, veja Capítulo 3, Personalização de perfis afinados.

3.11. Informações relacionadas

-

A página do homem

tuned.conf(5) - O site do projeto Tuned: https://tuned-project.org/

Capítulo 4. Revisão de um sistema usando interface de atum

Use a ferramenta tuna para ajustar as sintonizações do programador, ajustar a prioridade da rosca, os manipuladores IRQ e isolar os núcleos e soquetes da CPU. O atum reduz a complexidade de executar tarefas de sintonização.

4.1. Instalando a ferramenta atum

A ferramenta tuna foi projetada para ser usada em um sistema em funcionamento. Isto permite que ferramentas de medição específicas da aplicação vejam e analisem o desempenho do sistema imediatamente após as mudanças terem sido feitas.

A ferramenta tuna realiza as seguintes operações:

- Lista as CPUs em um sistema

- Lista os pedidos de interrupção (IRQs) atualmente em funcionamento em um sistema

- Altera a política e as informações prioritárias sobre os tópicos

- Exibe as políticas e prioridades atuais de um sistema

Procedimento

Para instalar a ferramenta

tuna:# yum instalar atum

Para exibir as opções disponíveis do

tunaCLI:# atum -h

Recursos adicionais

-

A página do homem

tuna.

4.2. Visualização do status do sistema usando a ferramenta atum

Este procedimento descreve como visualizar o status do sistema usando a ferramenta de interface de linha de comando (CLI) tuna.

Pré-requisitos

- A ferramenta atum está instalada. Para maiores informações, veja Seção 4.1, “Instalando a ferramenta atum”.

Procedimento

Para ver as políticas e prioridades atuais:

# tuna --show_threads thread pid SCHED_ rtpri affinity cmd 1 OTHER 0 0,1 init 2 FIFO 99 0 migration/0 3 OTHER 0 0 ksoftirqd/0 4 FIFO 99 0 watchdog/0Para visualizar uma linha específica correspondente a um PID ou que corresponda a um nome de comando:

# Atum --threads=pid_or_cmd_list --show_threadsO argumento pid_or_cmd_list é uma lista de PIDs separados por vírgula ou padrões de nomes de comando.

-

Para sintonizar as CPUs usando a

tunaCLI, ver Seção 4.3, “Sintonia de CPUs usando a ferramenta atum”. -

Para sintonizar os IRQs usando a ferramenta

tuna, ver Seção 4.4, “Ajuste de IRQs usando ferramenta de atum”. Para salvar a configuração alterada:

# Atum --guardar= nome do arquivo

Este comando salva atualmente apenas os fios do kernel em execução. Os processos que não estão em execução não são salvos.

Recursos adicionais

-

A página do homem

tuna. -

O comando

tuna -hexibe as opções CLI disponíveis.

4.3. Sintonia de CPUs usando a ferramenta atum

Os comandos da ferramenta tuna podem ter como alvo CPUs individuais. Usando a ferramenta atum, você pode:

Isolate CPUs- Todas as tarefas executadas na CPU especificada passam para a próxima CPU disponível. O isolamento de uma CPU a torna indisponível, removendo-a da máscara de afinidade de todas as roscas.

Include CPUs- Permite que as tarefas sejam executadas na CPU especificada

Restore CPUs- Restaura a CPU especificada para sua configuração anterior.

Este procedimento descreve como sintonizar as CPUs usando o tuna CLI.

Pré-requisitos

- A ferramenta atum está instalada. Para maiores informações, veja Seção 4.1, “Instalando a ferramenta atum”.

Procedimento

Para especificar a lista de CPUs a serem afetadas por um comando:

# atum --cpus=cpu_list [command]

O argumento cpu_list é uma lista de números de CPU separados por vírgula. Por exemplo,

--cpus=0,2. As listas de CPU também podem ser especificadas em uma série, por exemplo--cpus=”1-3”que selecionaria as CPUs 1, 2, e 3.Para adicionar uma CPU específica ao atual cpu_list, por exemplo, use

--cpus= 0.Substituir [command] por, por exemplo,

--isolate.Para isolar uma CPU:

# tuna --cpus=cpu_list --isolate

Para incluir uma CPU:

# atum --cpus=cpu_list --inclua

Para usar um sistema com quatro ou mais processadores, mostrar como fazer todos os threads ssh rodarem na CPU 0 e 1, e todos os threads

httpna CPU 2 e 3:# tuna --cpus=0,1 --threads=ssh\* \ --move --cpus=2,3 --threads=http\* --move

Este comando executa as seguintes operações sequencialmente:

- Seleciona as CPUs 0 e 1.

-

Seleciona todos os tópicos que começam com

ssh. - Movimenta os fios selecionados para as CPUs selecionadas. Atum define a máscara de afinidade dos fios, começando com ssh para as CPUs apropriadas. As CPUs podem ser expressas numericamente como 0 e 1, em máscara hexagonal como 0x3, ou em binário como 11.

- Redefine a lista de CPU para 2 e 3.

-

Seleciona todos os tópicos que começam com

http. -

Movimenta os fios selecionados para as CPUs especificadas. Tuna define a máscara de afinidade dos fios começando com

httppara as CPUs especificadas. As CPUs podem ser expressas numericamente como 2 e 3, em máscara hexadecimal como 0xC, ou em binário como 1100.

Etapas de verificação

Para exibir a configuração atual e verificar se as mudanças foram realizadas como esperado:

# tuna --threads=gnome-sc\* --show_threads \ --cpus=0 --move --show_threads --cpus=1 \ --move --show_threads --cpus=+0 --move --show_threads thread ctxt_switches pid SCHED_ rtpri affinity voluntary nonvoluntary cmd 3861 OTHER 0 0,1 33997 58 gnome-screensav thread ctxt_switches pid SCHED_ rtpri affinity voluntary nonvoluntary cmd 3861 OTHER 0 0 33997 58 gnome-screensav thread ctxt_switches pid SCHED_ rtpri affinity voluntary nonvoluntary cmd 3861 OTHER 0 1 33997 58 gnome-screensav thread ctxt_switches pid SCHED_ rtpri affinity voluntary nonvoluntary cmd 3861 OTHER 0 0,1 33997 58 gnome-screensav

Este comando executa as seguintes operações sequencialmente:

-

Seleciona todas as roscas que começam com as roscas

gnome-sc. - Exibe os fios selecionados para permitir que o usuário verifique sua máscara de afinidade e prioridade RT.

- Seleciona CPU 0.

-

Movimenta os fios

gnome-scpara a CPU especificada, CPU 0. - Mostra o resultado da mudança.

- Redefine a lista de CPU para CPU 1.

-

Movimenta os fios

gnome-scpara a CPU especificada, CPU 1. - Exibe o resultado da mudança.

- Adiciona a CPU 0 à lista de CPU.

-

Move os tópicos

gnome-scpara as CPUs especificadas, CPUs 0 e 1. - Exibe o resultado da mudança.

-

Seleciona todas as roscas que começam com as roscas

Recursos adicionais

-

O arquivo

/proc/cpuinfo. -

A página do homem

tuna. -

O comando

tuna -hexibe as opções CLI disponíveis.

4.4. Ajuste de IRQs usando ferramenta de atum

O arquivo /proc/interrupts registra o número de interrupções por IRQ, o tipo de interrupção, e o nome do dispositivo que está localizado nesse IRQ. Este procedimento descreve como afinar os IRQs usando a ferramenta tuna.

Pré-requisitos

- A ferramenta atum está instalada. Para maiores informações, veja Seção 4.1, “Instalando a ferramenta atum”.

Procedimento

Para ver os IRQs atuais e sua afinidade:

# tuna --show_irqs # users affinity 0 timer 0 1 i8042 0 7 parport0 0

Para especificar a lista de IRQs a serem afetados por um comando:

# atum --irqs=irq_list [command]

O argumento irq_list é uma lista de números IRQ separados por vírgula ou padrões de nomes de usuários.

Substituir [command] por, por exemplo,

--isolate.Para mover uma interrupção para uma CPU especificada:

# tuna --irqs=128 --show_irqs # users affinity 128 iwlwifi 0,1,2,3 # tuna --irqs=128 --cpus=3 --move

Substituir 128 pelo argumento irq_list e 3 pelo argumento cpu_list.

O argumento cpu_list é uma lista de números de CPU separados por vírgula, por exemplo,

--cpus=0,2. Para mais informações, ver Seção 4.3, “Sintonia de CPUs usando a ferramenta atum”.

Etapas de verificação

Compare o estado dos IRQs selecionados antes e depois de mover qualquer interrupção para uma CPU especificada:

# tuna --irqs=128 --show_irqs # users affinity 128 iwlwifi 3

Recursos adicionais

-

O arquivo

/procs/interrupts. -

A página do homem

tuna. -

O comando

tuna -hexibe as opções CLI disponíveis.

Capítulo 5. Monitoramento do desempenho usando os papéis do Sistema RHEL

5.1. Introdução aos papéis do sistema RHEL

O Sistema RHEL Roles é um conjunto de funções e módulos possíveis. As funções do sistema RHEL fornecem uma interface de configuração para gerenciar remotamente vários sistemas RHEL. A interface permite gerenciar configurações de sistema através de múltiplas versões do RHEL, bem como adotar novas versões principais.

No Red Hat Enterprise Linux 8, a interface atualmente consiste nas seguintes funções:

- kdump

- rede

- selinux

- armazenagem

- certificado

- kernel_settings

- madeireiro

- métricas

- nbde_client e nbde_server

- timesync

- tlog

Todas essas funções são fornecidas pelo pacote rhel-system-roles disponível no repositório AppStream.

Recursos adicionais

- Para uma visão geral dos Papéis do Sistema RHEL, veja o artigo do Red Hat Enterprise Linux (RHEL) System Roles Red Hat Knowledgebase.

-

Para informações sobre uma função específica, consulte a documentação sob o diretório

/usr/share/doc/rhel-system-roles. Esta documentação é instalada automaticamente com o pacoterhel-system-roles.

5.2. Terminologia dos papéis do Sistema RHEL

Você pode encontrar os seguintes termos ao longo desta documentação:

Terminologia dos papéis do sistema

- Livro de jogo possível

- Os playbooks são a linguagem de configuração, implantação e orquestração do Ansible. Eles podem descrever uma política que você quer que seus sistemas remotos apliquem, ou um conjunto de passos em um processo geral de TI.

- Nó de controle

- Qualquer máquina com Ansible instalado. Você pode executar comandos e playbooks, invocando /usr/bin/ansible ou /usr/bin/ansible-playbook, a partir de qualquer nó de controle. Você pode usar qualquer computador que tenha o Python instalado nele como um nó de controle - laptops, desktops compartilhados e servidores podem todos rodar o Ansible. Entretanto, você não pode usar uma máquina Windows como nó de controle. Você pode ter múltiplos nós de controle.

- Inventário

- Uma lista de nós administrados. Um arquivo de inventário também é às vezes chamado de "arquivo hospedeiro". Seu inventário pode especificar informações como endereço IP para cada nó gerenciado. Um inventário também pode organizar nós administrados, criando e aninhando grupos para facilitar o escalonamento. Para saber mais sobre o inventário, consulte a seção Trabalhando com o inventário.

- Nós administrados

- Os dispositivos de rede, servidores, ou ambos que você administra com Ansible. Os nós gerenciados também são às vezes chamados de "hosts". O Ansible não é instalado em nós gerenciados.

5.3. Instalação de funções do sistema RHEL em seu sistema

Este parágrafo é a introdução do módulo de procedimento: uma breve descrição do procedimento.

Pré-requisitos

- Você tem uma assinatura de Red Hat Ansible Engine. Veja o procedimento Como faço para baixar e instalar o Red Hat Ansible Engine?

- Você tem os pacotes Ansíveis instalados no sistema que você deseja usar como nó de controle:

Procedimento

Instale o pacote

rhel-system-rolesno sistema que você deseja usar como nó de controle:# yum instalar rhel-system-roles

Se você não tiver uma assinatura do Red Hat Ansible Engine, você pode usar uma versão suportada limitada do Red Hat Ansible Engine fornecida com sua assinatura do Red Hat Enterprise Linux. Neste caso, siga estes passos:

Habilitar o repositório RHEL Ansible Engine:

# subscription-manager refresh # subscription-manager repos --enable ansible-2-for-rhel-8-x86_64-rpms

Instalar Motor Possível:

# yum instalar possível

Como resultado, você é capaz de criar um livro de brincadeiras possível.

Recursos adicionais

- Para visão geral dos papéis do sistema RHEL, veja os papéis do sistema Red Hat Enterprise Linux (RHEL)

- Para informações mais detalhadas sobre o uso do comando ansible-playbook, consulte a página de manual ansible-playbook.

5.4. Aplicando um papel

O procedimento a seguir descreve como aplicar uma função específica.

Pré-requisitos

O pacote

rhel-system-rolesestá instalado no sistema que você deseja usar como um nó de controle:# yum install rhel-system-rolesO repositório Ansible Engine está habilitado, e o pacote

ansibleestá instalado no sistema que você deseja usar como um nó de controle. Você precisa do pacoteansiblepara executar playbooks que usam os papéis do sistema RHEL.Se você não tiver uma assinatura do Red Hat Ansible Engine, você pode usar uma versão suportada limitada do Red Hat Ansible Engine fornecida com sua assinatura do Red Hat Enterprise Linux. Neste caso, siga estes passos:

Habilitar o repositório RHEL Ansible Engine:

# subscription-manager refresh # subscription-manager repos --enable ansible-2-for-rhel-8-x86_64-rpms

Instalar Motor Possível:

# yum install ansible

- Se você tem uma assinatura de Red Hat Ansible Engine, siga o procedimento descrito em Como faço para baixar e instalar o Red Hat Ansible Engine?

Você é capaz de criar um livro de brincadeiras possível.

Os playbooks representam a linguagem de configuração, implantação e orquestração do Ansible. Usando playbooks, você pode declarar e gerenciar configurações de máquinas remotas, implantar várias máquinas remotas ou etapas de orquestração de qualquer processo encomendado manualmente.

Um playbook é uma lista de um ou mais

plays. Cadaplaypode incluir variáveis, tarefas ou papéis possíveis.Os livros didáticos são legíveis por humanos e são expressos no formato

YAML.Para mais informações sobre livros didáticos, consulte Documentação possível.

Procedimento

Crie um caderno de atividades, incluindo o papel necessário.

O exemplo a seguir mostra como usar os papéis através da opção

roles:para um determinadoplay:--- - hosts: webservers roles: - rhel-system-roles.network - rhel-system-roles.timesyncPara mais informações sobre o uso de papéis em livros didáticos, consulte Documentação possível.

Veja Exemplos possíveis, por exemplo, livros didáticos.

NotaCada função inclui um arquivo README, que documenta como utilizar a função e os valores dos parâmetros suportados. Você também pode encontrar um exemplo de playbook para um determinado papel sob o diretório de documentação do papel. Tal diretório de documentação é fornecido por padrão com o pacote

rhel-system-roles, e pode ser encontrado no local a seguir:/usr/share/doc/rhel-system-roles/SUBSYSTEM/Substituir SUBSYSTEM pelo nome da função requerida, como

selinux,kdump,network,timesync, oustorage.Verificar a sintaxe do playbook:

#

ansible-playbook --syntax-check name.of.the.playbookO comando

ansible-playbookoferece uma opção--syntax-checkque você pode usar para verificar a sintaxe de um playbook.Executar o playbook nos anfitriões-alvo executando o comando

ansible-playbook:#

ansible-playbook -i name.of.the.inventory name.of.the.playbookUm inventário é uma lista de sistemas contra os quais o Ansible funciona. Para mais informações sobre como criar e inventariar, e como trabalhar com ele, consulte a documentação do Ansible.

Se você não tiver um inventário, você pode criá-lo no momento da execução

ansible-playbook:Se você tiver apenas um anfitrião específico contra o qual você deseja executar o playbook, use:

# ansible-playbook -i host1, name.of.the.playbookSe você tiver vários anfitriões alvo contra os quais você deseja executar o livro de jogo, use:

# ansible-playbook -i host1,host2,....,hostn name.of.the.playbook

Recursos adicionais

-

Para obter informações mais detalhadas sobre o uso do comando

ansible-playbook, consulte a página de manualansible-playbook.

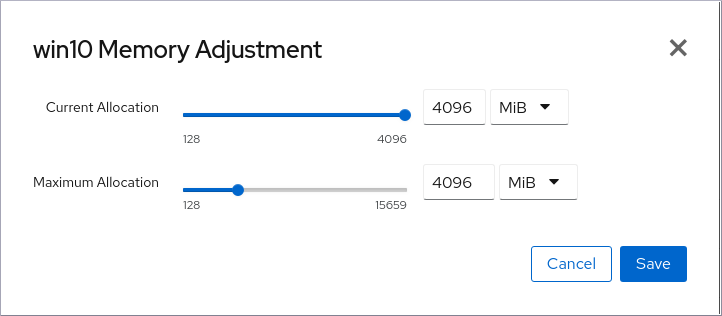

5.5. Introdução ao sistema métrico Papel do sistema

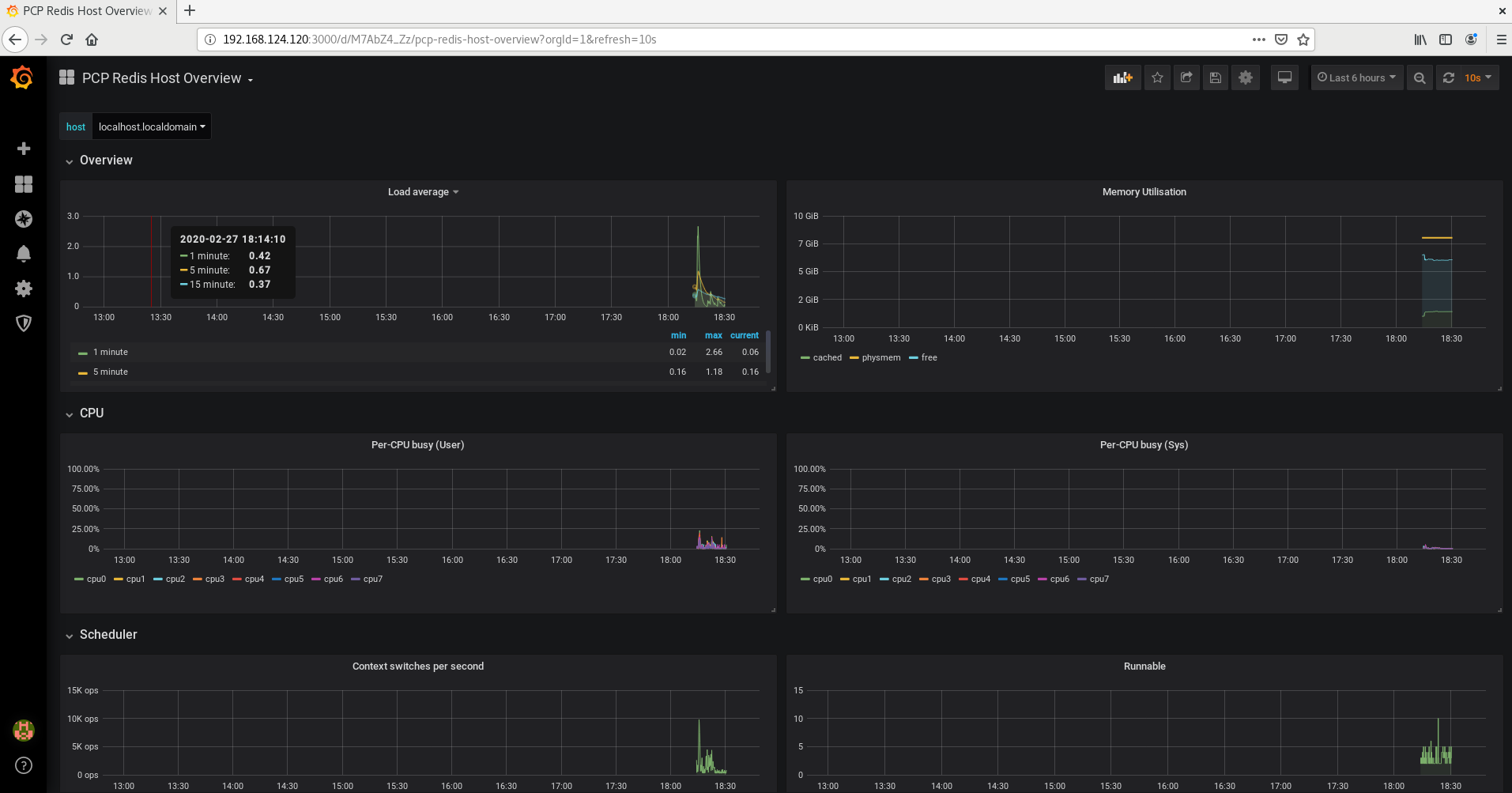

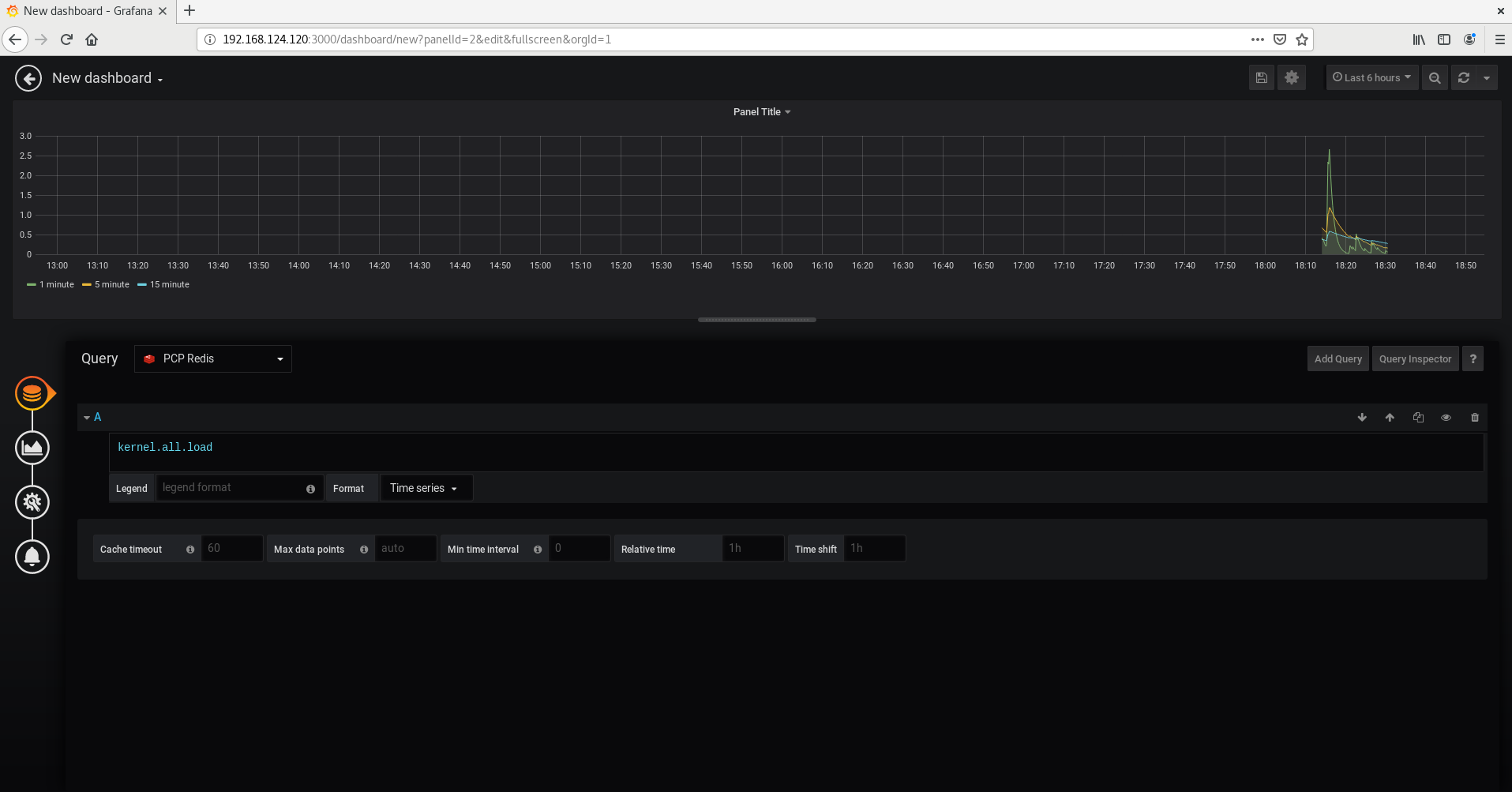

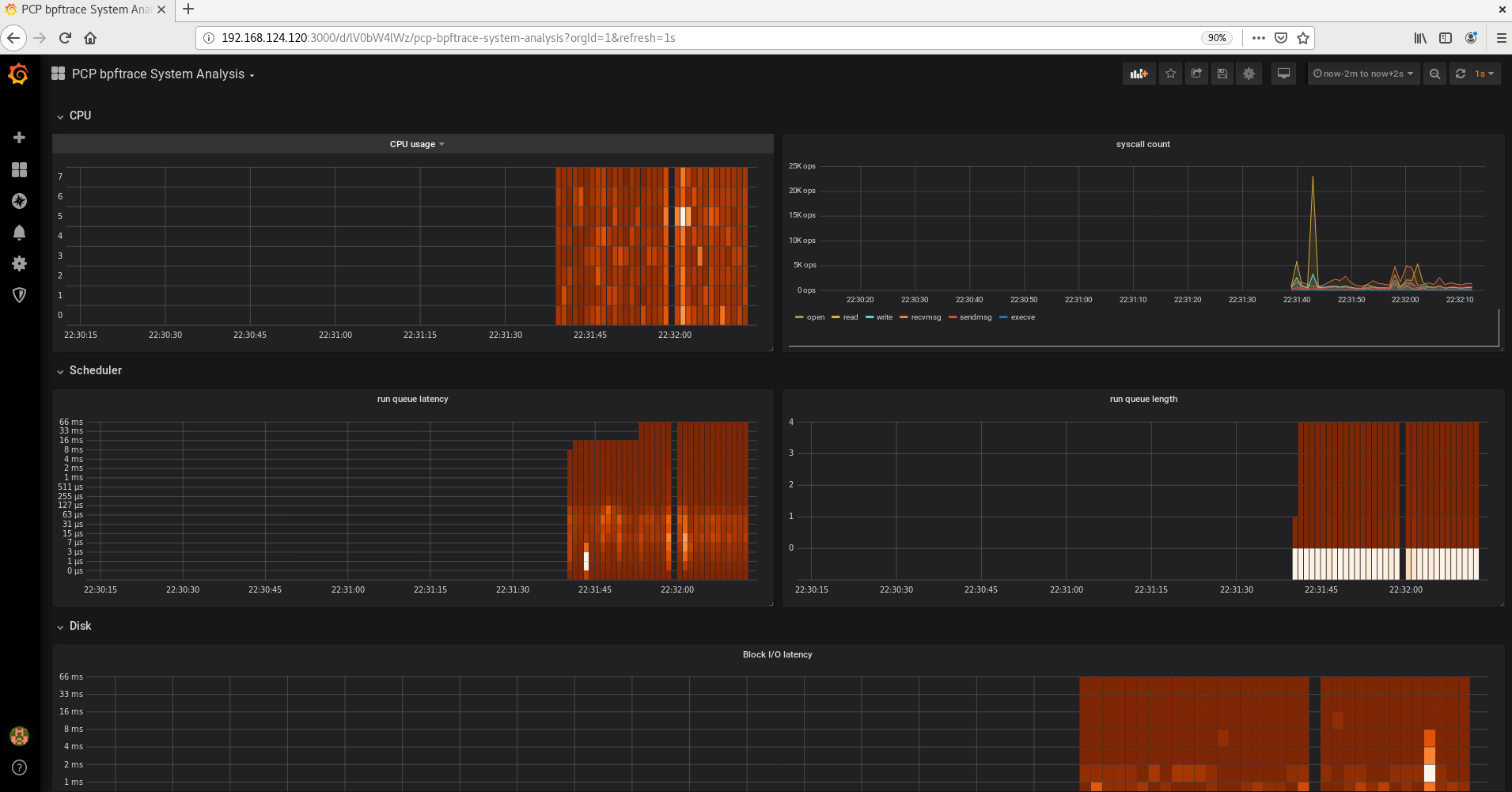

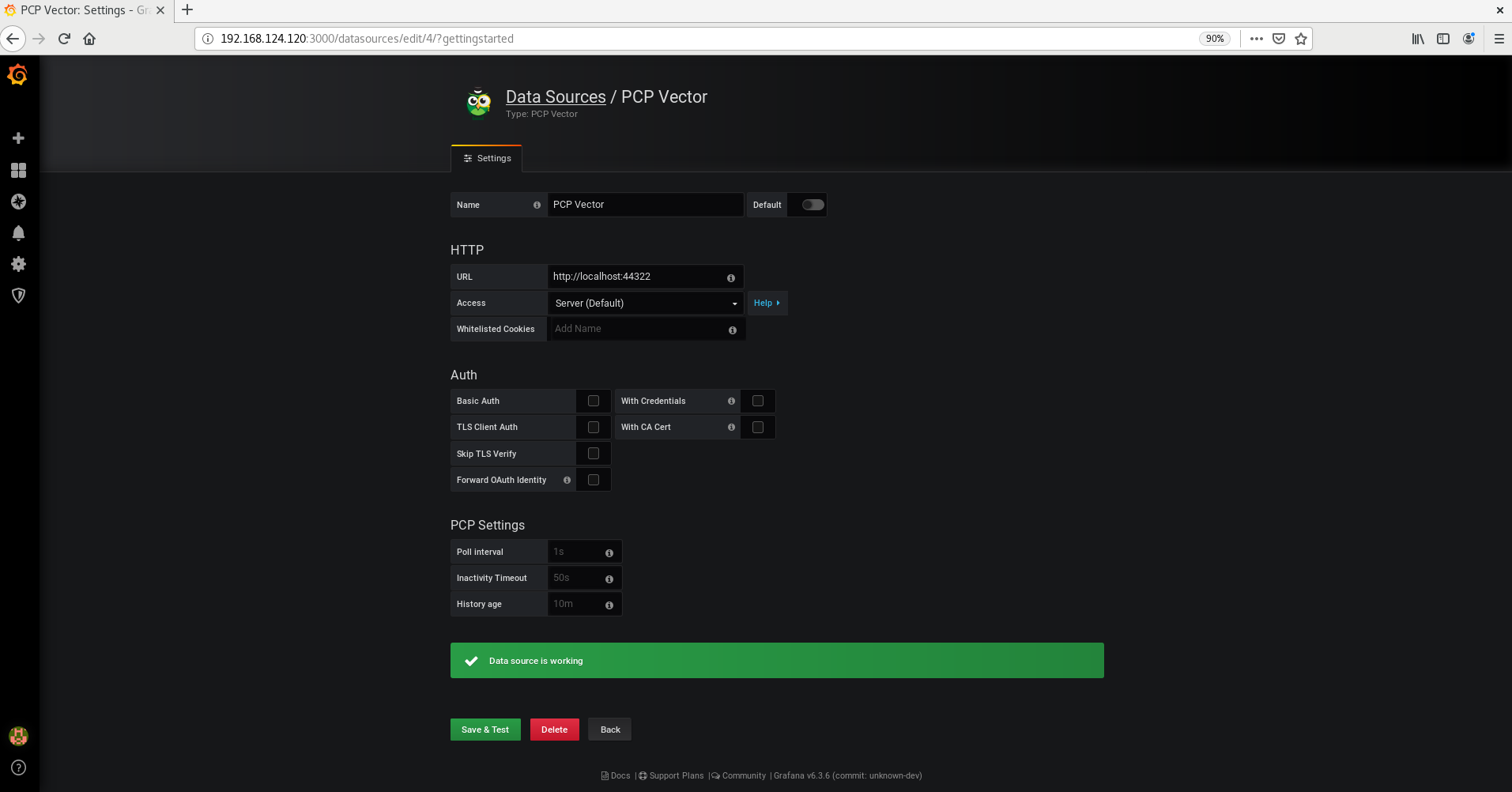

As funções do sistema RHEL são um conjunto de funções e módulos possíveis que fornecem uma interface de configuração consistente para gerenciar remotamente vários sistemas RHEL. A função do sistema de métricas configura serviços de análise de desempenho para o sistema local e, opcionalmente, inclui uma lista de sistemas remotos a serem monitorados pelo sistema local. O sistema de métricas System Role permite que você use pcp para monitorar o desempenho de seus sistemas sem ter que configurar pcp separadamente, já que a configuração e implantação de pcp é tratada pelo playbook.

Tabela 5.1. Variáveis de papel do sistema métrico

| Função variável | Descrição | Exemplo de uso |

|---|---|---|

| métricas_monitoradas_hosts |

Lista de hospedeiros remotos a serem analisados pelo hospedeiro alvo. Estes anfitriões terão métricas registradas no anfitrião alvo, portanto, certifique-se de que existe espaço suficiente em disco abaixo de |

|

| dias_de_retenção_métrica | Configura o número de dias para retenção de dados de desempenho antes da exclusão. |

|

| metrics_graph_service |

Uma bandeira booleana que permite a instalação do host com serviços de visualização de dados de desempenho via |

|

| métrica_consulta_serviço |

Uma bandeira booleana que permite configurar o host com serviços de consulta de séries temporais para consulta de métricas registradas |

|

| metrics_provider |

Especifica qual métrica coletor a ser usada para fornecer métricas. Atualmente, |

|

Recursos adicionais

-

para detalhes sobre os parâmetros usados em

metrics_connectionse informações adicionais sobre a função do sistema métrico, veja o arquivo/usr/share/ansible/roles/rhel-system-roles.metrics/README.md.

5.6. Usando o sistema métrico Função do sistema para monitorar seu sistema local com visualização

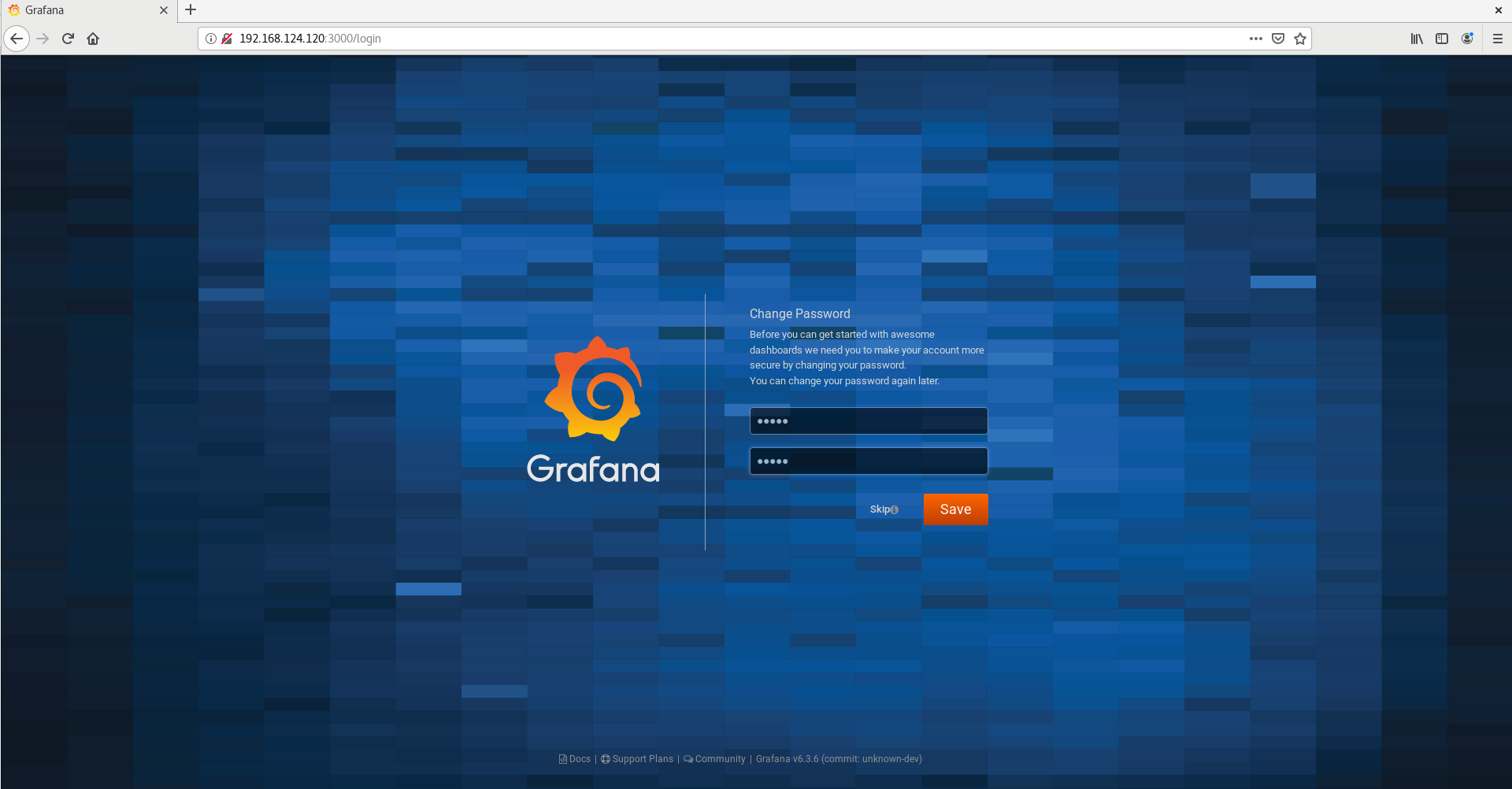

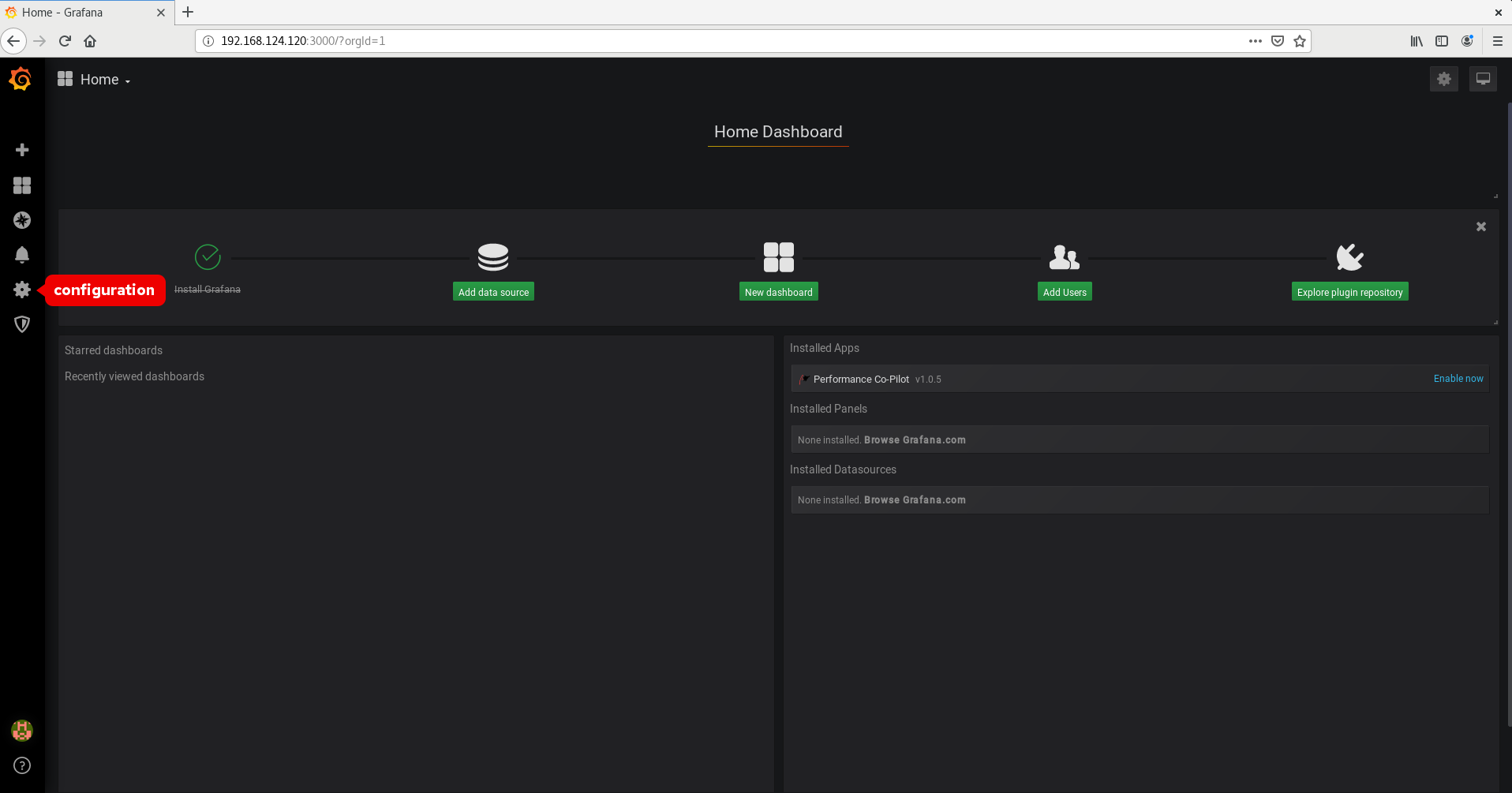

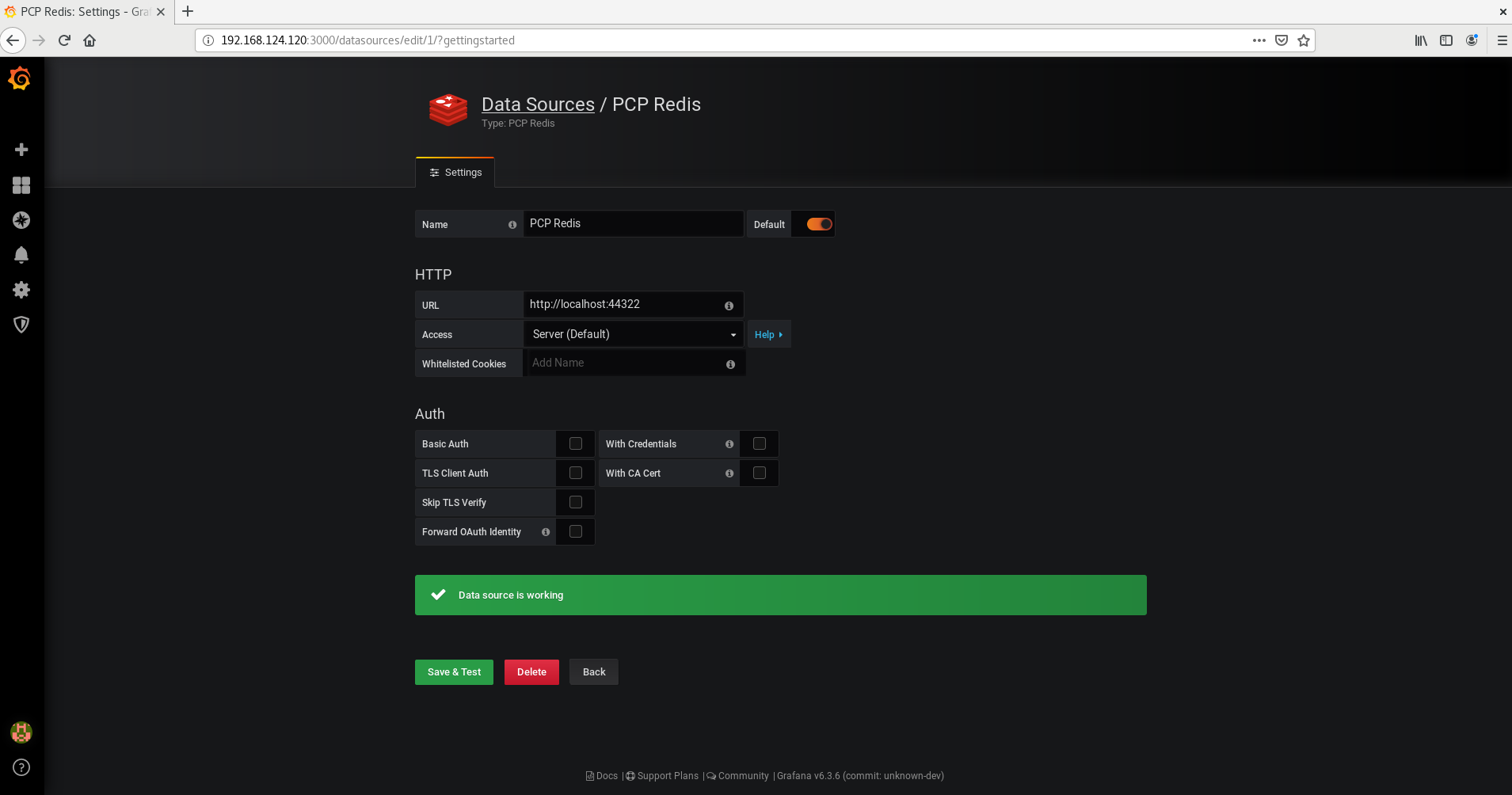

Este procedimento descreve como usar a métrica RHEL System Role para monitorar seu sistema local enquanto simultaneamente fornece a visualização de dados via grafana.

Pré-requisitos

- Você tem o Red Hat Ansible Engine instalado na máquina que você deseja monitorar.

-

Você tem o pacote

rhel-system-rolesinstalado na máquina que você deseja monitorar.

Procedimento

Configurar

localhostno site/etc/ansible/hostsInventário possível, adicionando o seguinte conteúdo ao inventário:localhost ansible_connection=local

Crie um livro de jogo possível com o seguinte conteúdo:

--- - hosts: localhost vars: metrics_graph_service: yes roles: - rhel-system-roles.metricsExecute o livro de jogo Ansible playbook:

# ansible-playbook name_of_your_playbook.ymlNotaComo o

metrics_graph_serviceboolean está configurado para value="yes",grafanaé automaticamente instalado e provisionado compcpadicionado como fonte de dados.-

Para visualizar a visualização das métricas que estão sendo coletadas em sua máquina, acesse a interface web

grafanacomo descrito em Accessing the Grafana web UI.

5.7. Usando o sistema métrico Função do sistema para configurar uma frota de sistemas individuais para monitorar a si mesmos

Este procedimento descreve como usar o sistema métrico Papel do sistema para montar uma frota de máquinas para monitorar a si mesmos.

Pré-requisitos

- Você tem o Red Hat Ansible Engine instalado na máquina que você deseja usar para executar o playbook.

-

Você tem o pacote

rhel-system-rolesinstalado na máquina que você deseja usar para executar o playbook.

Procedimento

Adicione o nome ou IP das máquinas que você deseja monitorar através do playbook ao arquivo

/etc/ansible/hosts. Um possível arquivo de inventário com um nome de grupo identificador entre parênteses:[remotes] webserver.example.com database.example.com

Crie um livro de jogo possível com o seguinte conteúdo:

--- - hosts: remotes vars: metrics_retention_days: 0 roles: - rhel-system-roles.metricsExecute o livro de jogo Ansible playbook:

# ansible-playbook name_of_your_playbook.yml

5.8. Usando o sistema métrico Papel do sistema para monitorar uma frota de máquinas de forma centralizada através de sua máquina local

Este procedimento descreve como usar o sistema de métricas Função do sistema para configurar sua máquina local para monitorar centralmente uma frota de máquinas, ao mesmo tempo em que fornece a visualização dos dados via grafana e consulta dos dados via redis.

Pré-requisitos

- Você tem o Red Hat Ansible Engine instalado na máquina que você deseja usar para executar o playbook.

-

Você tem o pacote

rhel-system-rolesinstalado na máquina que você deseja usar para executar o playbook.

Procedimento

Crie um livro de jogo possível com o seguinte conteúdo:

--- - hosts: localhost vars: metrics_graph_service: yes metrics_query_service: yes metrics_retention_days: 10 metrics_monitored_hosts: ["database.example.com", "webserver.example.com"] roles: - rhel-system-roles.metricsExecute o livro de jogo Ansible playbook:

# ansible-playbook name_of_your_playbook.ymlNotaComo as booleans

metrics_graph_serviceemetrics_query_serviceestão configuradas para value="yes",grafanaé automaticamente instalado e provisionado compcpadicionado como fonte de dados com o registro de dadospcpindexado emredis, permitindo que a linguagem de consultapcpseja usada para consulta complexa dos dados.-

Para visualizar a representação gráfica das métricas que estão sendo coletadas centralmente por sua máquina e para consultar os dados, acesse a interface web

grafanaconforme descrito em Accessing the Grafana web UI.

Capítulo 6. Monitorando o desempenho com o Co-Piloto de Desempenho

Como administrador de sistemas, você pode monitorar o desempenho do sistema usando o aplicativo Performance Co-Pilot (PCP) no Red Hat Enterprise Linux 8.

6.1. Visão geral do PCP

O PCP é um conjunto de ferramentas, serviços e bibliotecas para monitoramento, visualização, armazenamento e análise de medidas de desempenho em nível de sistema.

Características do PCP:

- Arquitetura distribuída leve, que é útil durante a análise centralizada de sistemas complexos.

- Ele permite o monitoramento e o gerenciamento de dados em tempo real.

- Ele permite o registro e a recuperação de dados históricos.

Você pode adicionar métricas de desempenho usando interfaces Python, Perl, C , e C. Ferramentas de análise podem usar as APIs clientes Python, C , C diretamente, e aplicações web ricas podem explorar todos os dados de desempenho disponíveis usando uma interface JSON.

Você pode analisar padrões de dados comparando resultados ao vivo com dados arquivados.

O PCP tem os seguintes componentes:

-

O Performance Metric Collector Daemon (

pmcd) coleta dados de desempenho dos Agentes do Domínio Performance Metric instalados (pmda). PMDAs pode ser carregado ou descarregado individualmente no sistema e são controlados pelo PMCD no mesmo host. -

Várias ferramentas do cliente, tais como

pminfooupmstat, podem recuperar, exibir, arquivar e processar esses dados no mesmo host ou através da rede. -

O pacote

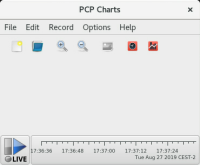

pcpfornece as ferramentas de linha de comando e a funcionalidade subjacente. -

O pacote

pcp-guifornece a aplicação gráfica. Instale o pacotepcp-guiexecutando o comandoyum install pcp-gui. Para maiores informações, veja Seção 6.6, “Rastreamento visual dos arquivos de log do PCP com a aplicação PCP Charts ”.

Recursos adicionais

-

O diretório

/usr/share/doc/pcp-doc/. - Seção 6.9, “Ferramentas distribuídas com PCP”.

- Os artigos, soluções, tutoriais e white papers do Index of Performance Co-Pilot (PCP ) no Portal do Cliente da Red Hat.

- O artigo Side-by-side comparison of PCP tools with legacy tools Red Hat Knowledgebase.

- A documentação do PCP a montante.

6.2. Instalando e habilitando o PCP

Para começar a usar o PCP, instale todos os pacotes necessários e habilite os serviços de monitoramento do PCP.

Procedimento

Instalar o pacote PCP:

# yum instalar pcp

Habilite e inicie o serviço

pmcdna máquina host:# systemctl enable pmcd # systemctl start pmcd

Verifique se o processo

pmcdestá rodando no host e se o XFS PMDA está listado como habilitado na configuração:# pcp Performance Co-Pilot configuration on workstation: platform: Linux workstation 4.18.0-80.el8.x86_64 #1 SMP Wed Mar 13 12:02:46 UTC 2019 x86_64 hardware: 12 cpus, 2 disks, 1 node, 36023MB RAM timezone: CEST-2 services: pmcd pmcd: Version 4.3.0-1, 8 agents pmda: root pmcd proc xfs linux mmv kvm jbd2

Recursos adicionais