Red Hat Training

A Red Hat training course is available for RHEL 8

Gerenciamento de dispositivos de armazenamento

Implementação e configuração de armazenamento de nó único no Red Hat Enterprise Linux 8

Resumo

Tornando o código aberto mais inclusivo

A Red Hat tem o compromisso de substituir a linguagem problemática em nosso código, documentação e propriedades da web. Estamos começando com estes quatro termos: master, slave, blacklist e whitelist. Por causa da enormidade deste esforço, estas mudanças serão implementadas gradualmente ao longo de vários lançamentos futuros. Para mais detalhes, veja a mensagem de nosso CTO Chris Wright.

Fornecendo feedback sobre a documentação da Red Hat

Agradecemos sua contribuição em nossa documentação. Por favor, diga-nos como podemos melhorá-la. Para fazer isso:

Para comentários simples sobre passagens específicas:

- Certifique-se de que você está visualizando a documentação no formato Multi-page HTML. Além disso, certifique-se de ver o botão Feedback no canto superior direito do documento.

- Use o cursor do mouse para destacar a parte do texto que você deseja comentar.

- Clique no pop-up Add Feedback que aparece abaixo do texto destacado.

- Siga as instruções apresentadas.

Para enviar comentários mais complexos, crie um bilhete Bugzilla:

- Ir para o site da Bugzilla.

- Como Componente, use Documentation.

- Preencha o campo Description com sua sugestão de melhoria. Inclua um link para a(s) parte(s) relevante(s) da documentação.

- Clique em Submit Bug.

Capítulo 1. Visão geral das opções de armazenamento disponíveis

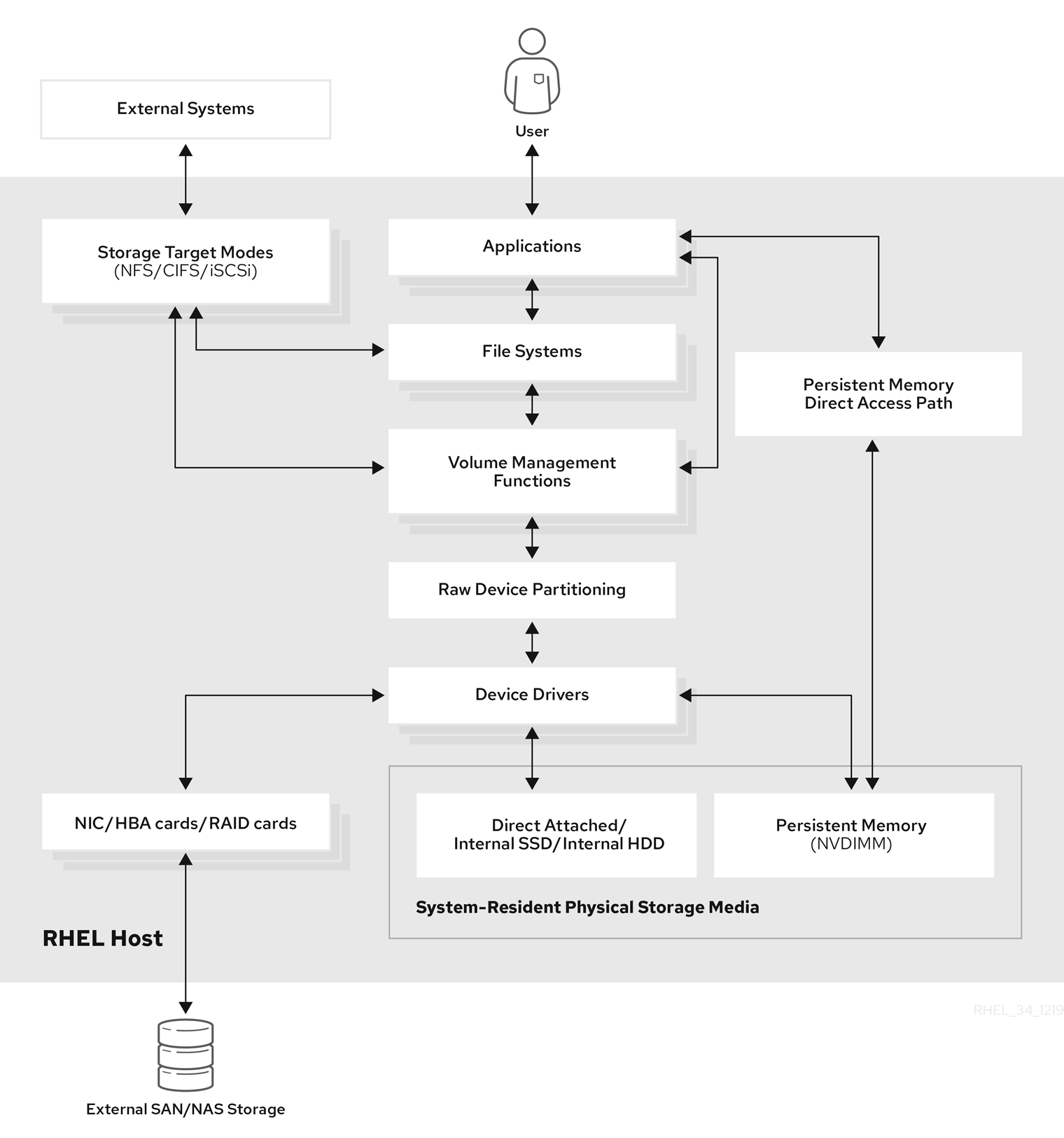

Este capítulo descreve os tipos de armazenamento que estão disponíveis no Red Hat Enterprise Linux 8. O Red Hat Enterprise Linux oferece uma variedade de opções para gerenciar o armazenamento local e para anexar ao armazenamento remoto. Figura 1.1, “Diagrama de armazenamento de alto nível do Red Hat Enterprise Linux” descreve as diferentes opções de armazenamento:

Figura 1.1. Diagrama de armazenamento de alto nível do Red Hat Enterprise Linux

1.1. Opções de armazenamento local

A seguir estão as opções de armazenamento local disponíveis no Red Hat Enterprise Linux 8:

- Administração básica do disco

Usando partições e fdisk, você pode criar, modificar, apagar e visualizar as partições. A seguir estão os padrões de layout das divisórias:

- Registro de Bota Principal (MBR)

- É utilizado com computadores baseados em BIOS. É possível criar partições primárias, ampliadas e lógicas.

- Tabela de partição do GUID (GPT)

- Ele usa um identificador global único (GUID) e fornece um GUID exclusivo de disco e partição.

Para criptografar a partição, você pode usar o Linux Unified Key Setup-on-disk-format (LUKS). Para criptografar a partição, selecione a opção durante a instalação e o prompt de visualização para inserir a frase-chave. Esta frase-chave desbloqueia a chave de criptografia.

- Opções de consumo de armazenamento

- Gestão de Módulos de Memória em Linha Dupla Não-Volátil (NVDIMM)

- É uma combinação de memória e armazenamento. Você pode ativar e gerenciar vários tipos de armazenamento em dispositivos NVDIMM conectados ao seu sistema.

- Gerenciamento de armazenamento em bloco

- Os dados são armazenados sob a forma de blocos onde cada bloco tem um identificador único.

- Armazenamento de arquivos

- Os dados são armazenados em nível de arquivo no sistema local. Estes dados podem ser acessados localmente usando XFS (padrão) ou ext4, e através de uma rede, usando NFS e SMB.

- Volumes lógicos

- Gerenciador de Volume Lógico (LVM)

Ele cria dispositivos lógicos a partir de dispositivos físicos. O volume lógico (LV) é uma combinação dos volumes físicos (PV) e grupos de volume (VG). A configuração de LVM inclui:

- Criando PV a partir dos discos rígidos.

- Criação de VG a partir do PV.

- Criação do LV a partir da VG atribuindo pontos de montagem ao LV.

- Otimizador de Dados Virtual (VDO)

É utilizado para a redução de dados através da deduplicação, compressão e provisionamento fino. O uso do LV abaixo do VDO ajuda a entrar:

- Ampliação do volume VDO

- Abrangendo o volume VDO em múltiplos dispositivos

- Sistemas de arquivo locais

- XFS

- O sistema de arquivos padrão da RHEL.

- Ext4

- Um sistema de arquivo legado.

- Stratis

- Está disponível como uma Pré-visualização Tecnológica. O Stratis é um sistema híbrido de gerenciamento de armazenamento local de usuário e núcleo que suporta recursos avançados de armazenamento.

1.2. Opções de armazenamento remoto

A seguir estão as opções de armazenamento remoto disponíveis no Red Hat Enterprise Linux 8:

- Opções de conectividade de armazenamento

- iSCSI

- A RHEL 8 utiliza a ferramenta targetcli para adicionar, remover, visualizar e monitorar as interconexões de armazenamento iSCSI.

- Canal de Fibra (FC)

O Red Hat Enterprise Linux 8 fornece os seguintes drivers nativos do Fibre Channel:

-

lpfc -

qla2xxx -

Zfcp

-

- Expressão de memória não volátil (NVMe)

Uma interface que permite que o utilitário de software hospedeiro se comunique com acionamentos em estado sólido. Use os seguintes tipos de transporte de tecido para configurar o NVMe sobre tecidos:

- NVMe sobre tecidos usando o Remote Direct Memory Access (RDMA).

- NVMe sobre tecidos usando Fibre Channel (FC)

- Dispositivo Mapper multipathing (DM Multipath)

- Permite configurar múltiplos caminhos de E/S entre nós de servidor e matrizes de armazenamento em um único dispositivo. Estes caminhos de E/S são conexões SAN físicas que podem incluir cabos, interruptores e controladores separados.

- Sistema de arquivo em rede

- NFS

- SMB

1.3. Solução em cluster do sistema de arquivos GFS2

O sistema de arquivo Global File System 2 (GFS2) da Red Hat é um sistema de arquivo de cluster simétrico de 64 bits que fornece um espaço de nome compartilhado e gerencia a coerência entre múltiplos nós que compartilham um dispositivo de bloco comum. Um sistema de arquivo GFS2 destina-se a fornecer um conjunto de recursos que é o mais próximo possível de um sistema de arquivo local, ao mesmo tempo em que reforça a coerência total do cluster entre os nós. Para conseguir isso, os nós empregam um esquema de travamento em cluster para os recursos do sistema de arquivos. Este esquema de travamento utiliza protocolos de comunicação como o TCP/IP para trocar informações de travamento.

Em alguns casos, a API do sistema de arquivos Linux não permite que a natureza de cluster do GFS2 seja totalmente transparente; por exemplo, programas que utilizam bloqueios POSIX no GFS2 devem evitar o uso da função GETLK uma vez que, em um ambiente de cluster, a identificação do processo pode ser para um nó diferente no cluster. Na maioria dos casos, entretanto, a funcionalidade de um sistema de arquivos GFS2 é idêntica à de um sistema de arquivos local.

O Complemento de Armazenamento Resiliente do Red Hat Enterprise Linux (RHEL) fornece o GFS2, e depende do Complemento de Alta Disponibilidade RHEL para fornecer o gerenciamento de cluster exigido pelo GFS2.

O módulo do kernel gfs2.ko implementa o sistema de arquivos GFS2 e é carregado nos nós de cluster GFS2.

Para obter o melhor desempenho do GFS2, é importante levar em conta as considerações de desempenho que decorrem do projeto subjacente. Assim como um sistema de arquivo local, o GFS2 depende do cache de páginas para melhorar o desempenho através do cache local de dados freqüentemente utilizados. Para manter a coerência entre os nós no cluster, o controle do cache é fornecido pela máquina do estado glock.

Recursos adicionais

- Para mais informações sobre os sistemas de arquivo GFS2, consulte a documentação Configurando os sistemas de arquivo GFS2.

1.4. Soluções aglomeradas

Esta seção fornece uma visão geral das opções agrupadas, tais como Red Hat Gluster Storage (RHGS) ou Red Hat Ceph Storage (RHCS).

1.4.1. Opção de armazenamento Red Hat Gluster

O Red Hat Gluster Storage (RHGS) é uma plataforma de armazenamento definida por software. Ela agrega recursos de armazenamento em disco de múltiplos servidores em um único namespace global. O GlusterFS é um sistema de arquivo distribuído de código aberto. Ele é adequado para soluções híbridas e em nuvem.

O GlusterFS consiste em diferentes tipos de volume, que são a base do GlusterFS e fornecem diferentes requisitos. O volume é uma coleção dos tijolos, que são o próprio espaço de armazenamento.

Os tipos de volume GlusterFS são os seguintes:

- Distributed GlusterFS volume é o volume padrão. Neste caso, cada arquivo é armazenado em um único tijolo e não pode ser compartilhado entre tijolos diferentes.

- o tipoReplicated GlusterFS volume mantém as réplicas dos dados. Neste caso, se um tijolo falhar, o usuário ainda poderá acessar os dados.

- Distributed replicated GlusterFS volume é um volume híbrido que distribui réplicas sobre um grande número de sistemas. É adequado para o ambiente onde os requisitos de armazenamento em escala e alta confiabilidade são críticos.

Recursos adicionais

- Para mais informações sobre a RHGS, consulte o guia de administração de armazenamento de gluster da Red Hat.

1.4.2. Opção de armazenamento Red Hat Ceph

A Red Hat Ceph Storage (RHCS) é uma plataforma de armazenamento escalável, aberta e definida por software que combina a versão mais estável do sistema de armazenamento Ceph com uma plataforma de gerenciamento Ceph, utilitários de implantação e serviços de suporte.

O Red Hat Ceph Storage foi projetado para a infra-estrutura de nuvens e armazenamento de objetos em escala web. Os clusters de armazenamento Red Hat Ceph consistem nos seguintes tipos de nós:

- Armazenamento Red Hat Ceph Nó de administração possível

Este tipo de nó atua como o tradicional nó de Administração Ceph para as versões anteriores da Red Hat Ceph Storage. Este tipo de nó fornece as seguintes funções:

- Gerenciamento centralizado do cluster de armazenamento

- Os arquivos e chaves de configuração da Ceph

- Opcionalmente, repositórios locais para instalação do Ceph em nós que não podem acessar a Internet por razões de segurança

- Nós de monitoramento

Cada nó de monitor executa o daemon monitor (

ceph-mon), que mantém uma cópia matriz do mapa de agrupamento. O mapa de agrupamento inclui a topologia do agrupamento. Um cliente conectado ao cluster da Ceph recupera a cópia atual do mapa de cluster do monitor que permite ao cliente ler e escrever dados no cluster.ImportanteA Ceph pode funcionar com um monitor; entretanto, para garantir alta disponibilidade em um cluster de produção, a Red Hat só suportará implantações com pelo menos três nós de monitor. A Red Hat recomenda a implantação de um total de 5 monitores Ceph para clusters de armazenamento que excedam 750 OSDs.

- Nós OSD

Cada nó do Dispositivo de Armazenamento de Objetos (OSD) executa o daemon Ceph OSD (

ceph-osd), que interage com os discos lógicos anexados ao nó. A Ceph armazena dados sobre esses nós OSD.A Ceph pode funcionar com muito poucos nós OSD, que o padrão é três, mas os clusters de produção percebem melhor desempenho a partir de escalas modestas, por exemplo, 50 OSDs em um cluster de armazenamento. Idealmente, um cluster Ceph tem múltiplos nós OSD, permitindo domínios de falha isolados através da criação do mapa CRUSH.

- Nós MDS

-

Cada nó do Metadata Server (MDS) executa o daemon MDS (

ceph-mds), que gerencia os metadados relacionados aos arquivos armazenados no Ceph File System (CephFS). O daemon MDS também coordena o acesso ao cluster compartilhado. - Objeto Nó de porta de entrada

-

O nó Ceph Object Gateway executa o daemon Ceph RADOS Gateway (

ceph-radosgw), e é uma interface de armazenamento de objetos construída em cima delibradospara fornecer aplicações com um gateway RESTful para Ceph Storage Clusters. O gateway Ceph Object Gateway suporta duas interfaces: - S3

- Fornece funcionalidade de armazenamento de objetos com uma interface compatível com um grande subconjunto do Amazon S3 RESTful API.

- Swift

- Fornece funcionalidade de armazenamento de objetos com uma interface compatível com um grande subconjunto do OpenStack Swift API.

Recursos adicionais

- Para mais informações sobre a RHCS, consulte a documentação da Red Hat Ceph Storage.

Capítulo 2. Gerenciamento do armazenamento local usando as funções do sistema RHEL

Para gerenciar LVM e sistemas de arquivos locais (FS) usando o Ansible, você pode usar a função storage, que é uma das funções do Sistema RHEL disponível no RHEL 8.

O uso da função storage permite automatizar a administração de sistemas de arquivos em discos e volumes lógicos em múltiplas máquinas e em todas as versões da RHEL, começando com a RHEL 7.7.

Para mais informações sobre os papéis do Sistema RHEL e como aplicá-los, consulte Introdução aos papéis do Sistema RHEL.

2.1. Introdução à função de armazenamento

A função storage pode administrar:

- Sistemas de arquivos em discos que não foram particionados

- Grupos completos de volumes LVM incluindo seus volumes lógicos e sistemas de arquivo

Com o papel storage você pode realizar as seguintes tarefas:

- Criar um sistema de arquivo

- Remover um sistema de arquivo

- Montar um sistema de arquivo

- Desmontar um sistema de arquivo

- Criar grupos de volume LVM

- Remover grupos de volume LVM

- Criar volumes lógicos

- Remover volumes lógicos

- Criar volumes RAID

- Remover volumes RAID

- Criar pools LVM com RAID

- Remover as piscinas LVM com RAID

2.2. Parâmetros que identificam um dispositivo de armazenamento no papel do sistema de armazenamento

Sua configuração de funções storage afeta apenas os sistemas de arquivos, volumes e pools que você lista nas seguintes variáveis.

storage_volumesLista de sistemas de arquivos em todos os discos não particionados a serem gerenciados.

Atualmente, as partições não têm suporte.

storage_poolsLista de piscinas a serem administradas.

Atualmente, o único tipo de piscina suportada é a LVM. Com LVM, os pools representam grupos de volume (VGs). Sob cada pool há uma lista de volumes a serem gerenciados pela função. Com o LVM, cada volume corresponde a um volume lógico (LV) com um sistema de arquivo.

2.3. Exemplo Livro de reprodução possível para criar um sistema de arquivo XFS em um dispositivo de bloco

Esta seção fornece um exemplo de um livro de brincadeiras possível. Este playbook aplica o papel storage para criar um sistema de arquivos XFS em um dispositivo de bloco usando os parâmetros padrão.

A função storage pode criar um sistema de arquivo somente em um disco não particionado, inteiro ou em um volume lógico (LV). Ele não pode criar o sistema de arquivo em uma partição.

Exemplo 2.1. Um playbook que cria XFS em /dev/sdb

---

- hosts: all

vars:

storage_volumes:

- name: barefs

type: disk

disks:

- sdb

fs_type: xfs

roles:

- rhel-system-roles.storage-

O nome do volume (

barefsno exemplo) é atualmente arbitrária. A funçãostorageidentifica o volume pelo dispositivo de disco listado sob o atributodisks:. -

Você pode omitir a linha

fs_type: xfsporque XFS é o sistema de arquivo padrão no RHEL 8. Para criar o sistema de arquivo em um LV, forneça a configuração LVM sob o atributo

disks:, incluindo o grupo de volume envolvente. Para detalhes, veja Exemplo Livro de exemplo para gerenciar volumes lógicos.Não forneça o caminho para o dispositivo LV.

Recursos adicionais

-

Para detalhes sobre os parâmetros utilizados na função do sistema

storage, consulte o arquivo/usr/share/ansible/roles/rhel-system-roles.storage/README.md.

2.4. Exemplo Livro de reprodução possível para montar persistentemente um sistema de arquivo

Esta seção fornece um exemplo de um livro de brincadeiras possível. Este playbook aplica o papel storage para montar imediata e persistentemente um sistema de arquivos XFS.

Exemplo 2.2. Um playbook que monta um sistema de arquivo em /dev/sdb para /mnt/dados

---

- hosts: all

vars:

storage_volumes:

- name: barefs

type: disk

disks:

- sdb

fs_type: xfs

mount_point: /mnt/data

roles:

- rhel-system-roles.storage-

Este playbook adiciona o sistema de arquivo ao arquivo

/etc/fstab, e monta o sistema de arquivo imediatamente. -

Se o sistema de arquivo no dispositivo

/dev/sdbou o diretório de pontos de montagem não existir, o playbook os cria.

Recursos adicionais

-

Para detalhes sobre os parâmetros utilizados na função do sistema

storage, consulte o arquivo/usr/share/ansible/roles/rhel-system-roles.storage/README.md.

2.5. Exemplo Livro de exercícios possível para gerenciar volumes lógicos

Esta seção fornece um exemplo de um livro de brincadeiras possível. Este playbook aplica o papel storage para criar um volume lógico LVM em um grupo de volumes.

Exemplo 2.3. Um playbook que cria um volume lógico mylv no grupo de volume myvg

- hosts: all

vars:

storage_pools:

- name: myvg

disks:

- sda

- sdb

- sdc

volumes:

- name: mylv

size: 2G

fs_type: ext4

mount_point: /mnt

roles:

- rhel-system-roles.storageO grupo de volume

myvgé composto pelos seguintes discos:-

/dev/sda -

/dev/sdb -

/dev/sdc

-

-

Se o grupo de volume

myvgjá existe, o playbook adiciona o volume lógico ao grupo de volume. -

Se o grupo de volume

myvgnão existe, o playbook o cria. -

O playbook cria um sistema de arquivo Ext4 no volume lógico

mylve monta persistentemente o sistema de arquivo em/mnt.

Recursos adicionais

-

Para detalhes sobre os parâmetros utilizados na função do sistema

storage, consulte o arquivo/usr/share/ansible/roles/rhel-system-roles.storage/README.md.

2.6. Exemplo Livro de reprodução possível para permitir o descarte em bloco online

Esta seção fornece um exemplo de um livro de brincadeiras possível. Este playbook aplica o papel storage para montar um sistema de arquivo XFS com o descarte de blocos on-line habilitado.

Exemplo 2.4. Um playbook que permite o descarte de blocos online em /mnt/dados/

---

- hosts: all

vars:

storage_volumes:

- name: barefs

type: disk

disks:

- sdb

fs_type: xfs

mount_point: /mnt/data

mount_options: discard

roles:

- rhel-system-roles.storageRecursos adicionais

- Este playbook também realiza todas as operações do exemplo de montagem persistente descrito em Seção 2.4, “Exemplo Livro de reprodução possível para montar persistentemente um sistema de arquivo”.

-

Para detalhes sobre os parâmetros utilizados na função do sistema

storage, consulte o arquivo/usr/share/ansible/roles/rhel-system-roles.storage/README.md.

2.7. Exemplo Livro de reprodução possível para criar e montar um sistema de arquivo Ext4

Esta seção fornece um exemplo de um livro de brincadeiras possível. Este playbook aplica o papel storage para criar e montar um sistema de arquivos Ext4.

Exemplo 2.5. Um playbook que cria Ext4 em /dev/sdb e o monta em /mnt/dados

---

- hosts: all

vars:

storage_volumes:

- name: barefs

type: disk

disks:

- sdb

fs_type: ext4

fs_label: label-name

mount_point: /mnt/data

roles:

- rhel-system-roles.storage-

O playbook cria o sistema de arquivos no disco

/dev/sdb. -

O playbook monta persistentemente o sistema de arquivo no

/mnt/datadiretório. -

A etiqueta do sistema de arquivo é

label-name.

Recursos adicionais

-

Para detalhes sobre os parâmetros utilizados na função do sistema

storage, consulte o arquivo/usr/share/ansible/roles/rhel-system-roles.storage/README.md.

2.8. Exemplo Livro de reprodução possível para criar e montar um sistema de arquivo ext3

Esta seção fornece um exemplo de um livro de brincadeiras possível. Este playbook aplica o papel storage para criar e montar um sistema de arquivos Ext3.

Exemplo 2.6. Um playbook que cria Ext3 em /dev/sdb e o monta em /mnt/dados

---

- hosts: all

vars:

storage_volumes:

- name: barefs

type: disk

disks:

- sdb

fs_type: ext3

fs_label: label-name

mount_point: /mnt/data

roles:

- rhel-system-roles.storage-

O playbook cria o sistema de arquivos no disco

/dev/sdb. -

O playbook monta persistentemente o sistema de arquivo no

/mnt/datadiretório. -

A etiqueta do sistema de arquivo é

label-name.

Recursos adicionais

-

Para detalhes sobre os parâmetros utilizados na função do sistema

storage, consulte o arquivo/usr/share/ansible/roles/rhel-system-roles.storage/README.md.

2.9. Configuração de um volume RAID utilizando a função do sistema de armazenamento

Com o Sistema Função storage, você pode configurar um volume RAID na RHEL usando a Plataforma de Automação Possível Red Hat Ansible Automation. Nesta seção, você aprenderá como configurar um livro de jogo possível com os parâmetros disponíveis para configurar um volume RAID de acordo com suas necessidades.

Pré-requisitos

Você tem o Red Hat Ansible Engine instalado no sistema a partir do qual você deseja executar o playbook.

NotaVocê não precisa ter a Plataforma de Automação Possível da Red Hat instalada nos sistemas nos quais você deseja implantar a solução

storage.-

Você tem o pacote

rhel-system-rolesinstalado no sistema a partir do qual você deseja executar o playbook. -

Você tem um arquivo de inventário detalhando os sistemas nos quais você deseja implantar um volume RAID usando o sistema

storageFunção do sistema.

Procedimento

Criar um novo

playbook.ymlarquivo com o seguinte conteúdo:- hosts: all vars: storage_safe_mode: false storage_volumes: - name: data type: raid disks: [sdd, sde, sdf, sdg] raid_level: raid0 raid_chunk_size: 32 KiB mount_point: /mnt/data state: present roles: - name: rhel-system-roles.storageAtençãoOs nomes dos dispositivos podem mudar em certas circunstâncias; por exemplo, quando você adiciona um novo disco a um sistema. Portanto, para evitar a perda de dados, não recomendamos o uso de nomes de disco específicos no livro de reprodução.

Opcional. Verificar a sintaxe do playbook.

# ansible-playbook --syntax-check playbook.ymlExecute o playbook em seu arquivo de inventário:

# ansible-playbook -i inventory.file /path/to/file/playbook.yml

Recursos adicionais

- Para mais informações sobre o RAID, consulte Gerenciando RAID.

-

Para detalhes sobre os parâmetros utilizados na função do sistema de armazenamento, consulte o arquivo

/usr/share/ansible/roles/rhel-system-roles.storage/README.md.

2.10. Configuração de um pool LVM com RAID utilizando a função de sistema de armazenamento

Com o Sistema Função storage, você pode configurar um pool LVM com RAID na RHEL usando a Plataforma de Automação Possível da Red Hat. Nesta seção você aprenderá como configurar um playbook Ansible com os parâmetros disponíveis para configurar um pool LVM com RAID.

Pré-requisitos

Você tem o Red Hat Ansible Engine instalado no sistema a partir do qual você deseja executar o playbook.

NotaVocê não precisa ter a Plataforma de Automação Possível da Red Hat instalada nos sistemas nos quais você deseja implantar a solução

storage.-

Você tem o pacote

rhel-system-rolesinstalado no sistema a partir do qual você deseja executar o playbook. -

Você tem um arquivo de inventário detalhando os sistemas nos quais você deseja configurar um pool LVM com RAID usando o sistema

storageFunção do sistema.

Procedimento

Criar um novo

playbook.ymlarquivo com o seguinte conteúdo:- hosts: all vars: storage_safe_mode: false storage_pools: - name: my_pool type: lvm disks: [sdh, sdi] raid_level: raid1 volumes: - name: my_pool size: "1 GiB" mount_point: "/mnt/app/shared" fs_type: xfs state: present roles: - name: rhel-system-roles.storageNotaPara criar um pool LVM com RAID, você deve especificar o tipo de RAID usando o parâmetro

raid_level.Opcional. Verificar a sintaxe do playbook.

# ansible-playbook --syntax-check playbook.ymlExecute o playbook em seu arquivo de inventário:

# ansible-playbook -i inventory.file /path/to/file/playbook.yml

Recursos adicionais

- Para mais informações sobre o RAID, consulte Gerenciando RAID.

-

Para detalhes sobre os parâmetros utilizados na função do sistema de armazenamento, consulte o arquivo

/usr/share/ansible/roles/rhel-system-roles.storage/README.md.

2.11. Criação de um volume codificado LUKS usando a função de armazenamento

Você pode usar o papel storage para criar e configurar um volume criptografado com LUKS, executando um livro de brincadeiras Ansible playbook.

Pré-requisitos

Você tem o Red Hat Ansible Engine instalado no sistema a partir do qual você deseja executar o playbook.

NotaVocê não precisa ter a Plataforma de Automação Possível da Red Hat instalada nos sistemas nos quais você deseja criar o volume.

-

Você tem o pacote

rhel-system-rolesinstalado no controlador Ansible. - Você tem um arquivo de inventário detalhando os sistemas nos quais você deseja implantar um volume codificado LUKS usando a função de sistema de armazenamento.

Procedimento

Criar um novo

playbook.ymlarquivo com o seguinte conteúdo:- hosts: all vars: storage_volumes: - name: barefs type: disk disks: - sdb fs_type: xfs fs_label: label-name mount_point: /mnt/data encryption: true encryption_password: your-password roles: - rhel-system-roles.storageOpcional. Verificar a sintaxe do playbook:

# ansible-playbook --syntax-check playbook.ymlExecute o playbook em seu arquivo de inventário:

# ansible-playbook -i inventory.file /path/to/file/playbook.yml

Recursos adicionais

- Para mais informações sobre a LUKS, veja 17. Criptografando dispositivos de blocos usando LUKS...

-

Para detalhes sobre os parâmetros utilizados na função do sistema

storage, consulte o arquivo/usr/share/ansible/roles/rhel-system-roles.storage/README.md.

Recursos adicionais

Para mais informações, instale o pacote

rhel-system-rolese veja os seguintes diretórios:-

/usr/share/doc/rhel-system-roles/storage/ -

/usr/share/ansible/roles/rhel-system-roles.storage/

-

Capítulo 3. Começando com as divisórias

Como administrador do sistema, você pode usar os seguintes procedimentos para criar, excluir e modificar vários tipos de partições de disco.

Para uma visão geral das vantagens e desvantagens de usar divisórias em dispositivos de blocos, consulte o seguinte artigo da KBase: https://access.redhat.com/solutions/163853.

3.1. Visualização da mesa divisória

Como administrador de sistema, você pode exibir a tabela de partição de um dispositivo de bloco para ver o layout da partição e detalhes sobre as partições individuais.

3.1.1. Visualizando a mesa divisória com separação

Este procedimento descreve como visualizar a tabela de partição em um dispositivo de bloco usando o utilitário parted.

Procedimento

Inicie o shell interativo

parted:# Separado block-device-

Substitua block-device com o caminho para o dispositivo que você deseja examinar: por exemplo,

/dev/sda.

-

Substitua block-device com o caminho para o dispositivo que você deseja examinar: por exemplo,

Veja a tabela de partição:

(dividido) impressão

Opcionalmente, use o seguinte comando para mudar para outro dispositivo que você queira examinar a seguir:

(separados) selecione block-device

Recursos adicionais

-

A página do homem

parted(8).

3.1.2. Exemplo de saída de parted print

Esta seção fornece um exemplo de saída do comando print na shell parted e descreve os campos na saída.

Exemplo 3.1. Saída do comando print

Model: ATA SAMSUNG MZNLN256 (scsi) Disk /dev/sda: 256GB Sector size (logical/physical): 512B/512B Partition Table: msdos Disk Flags: Number Start End Size Type File system Flags 1 1049kB 269MB 268MB primary xfs boot 2 269MB 34.6GB 34.4GB primary 3 34.6GB 45.4GB 10.7GB primary 4 45.4GB 256GB 211GB extended 5 45.4GB 256GB 211GB logical

A seguir, uma descrição dos campos:

Model: ATA SAMSUNG MZNLN256 (scsi)- O tipo de disco, fabricante, número do modelo e interface.

Disk /dev/sda: 256GB- O caminho do arquivo para o dispositivo do bloco e a capacidade de armazenamento.

Partition Table: msdos- O tipo de etiqueta do disco.

Number-

O número da divisória. Por exemplo, a partição com número menor 1 corresponde a

/dev/sda1. StarteEnd- A localização no dispositivo onde começa e termina a divisória.

Type- Os tipos válidos são metadados, livres, primários, estendidos ou lógicos.

File system-

O tipo de sistema de arquivo. Se o campo

File systemde um dispositivo não mostrar nenhum valor, isto significa que seu tipo de sistema de arquivo é desconhecido. O utilitáriopartednão consegue reconhecer o sistema de arquivo em dispositivos criptografados. Flags-

Relaciona as bandeiras definidas para a divisória. As bandeiras disponíveis são

boot,root,swap,hidden,raid,lvm, oulba.

3.2. Criação de uma tabela de partição em um disco

Como administrador de sistema, você pode formatar um dispositivo de bloco com diferentes tipos de tabelas de partição para permitir o uso de partições no dispositivo.

A formatação de um dispositivo de bloco com uma tabela de partição elimina todos os dados armazenados no dispositivo.

3.2.1. Considerações antes de modificar as partições em um disco

Esta seção lista os pontos-chave a serem considerados antes de criar, remover ou redimensionar as divisórias.

Esta seção não cobre a tabela de partição DASD, que é específica para a arquitetura IBM Z. Para informações sobre o DASD, veja:

- Configuração de uma instância Linux na IBM Z

- O que você deve saber sobre o artigo DASD no Centro de Conhecimento da IBM

O número máximo de divisórias

O número de divisórias em um dispositivo é limitado pelo tipo da tabela de divisórias:

Em um dispositivo formatado com a tabela de partição Master Boot Record (MBR), você pode ter qualquer um dos dois:

- Até quatro partições primárias, ou

- Até três divisórias primárias, uma divisória estendida, e múltiplas divisórias lógicas dentro da estendida.

-

Em um dispositivo formatado com o GUID Partition Table (GPT), o número máximo de divisórias é de 128. Enquanto a especificação GPT permite mais partições aumentando a área reservada para a tabela de partição, a prática comum usada pelo utilitário

partedé limitá-la a uma área suficiente para 128 partições.

A Red Hat recomenda que, a menos que você tenha uma razão para fazer o contrário, você deve at least criar as seguintes partições: swap, /boot/, e / (raiz).

O tamanho máximo de uma divisória

O tamanho de uma divisória em um dispositivo é limitado pelo tipo da mesa divisória:

- Em um dispositivo formatado com a tabela de partição Master Boot Record (MBR), o tamanho máximo é 2TiB.

- Em um dispositivo formatado com o GUID Partition Table (GPT), o tamanho máximo é 8ZiB.

Se você quiser criar uma partição maior que 2TiB, o disco deve ser formatado com GPT.

Alinhamento de tamanhos

O utilitário parted permite especificar o tamanho da partição usando vários sufixos diferentes:

- MiB, GiB, ou TiB

Tamanho expresso em poderes de 2.

- O ponto de partida da divisória é alinhado ao setor exato especificado por tamanho.

- O ponto final é alinhado com o tamanho especificado menos 1 setor.

- MB, GB, ou TB

Tamanho expresso em poderes de 10.

O ponto inicial e final é alinhado dentro de uma metade da unidade especificada: por exemplo, ±500KB ao utilizar o sufixo MB.

3.2.2. Comparação dos tipos de mesas divisórias

Esta seção compara as propriedades de diferentes tipos de tabelas de partição que você pode criar em um dispositivo de bloco.

Tabela 3.1. Tipos de mesas divisórias

| Mesa divisória | Número máximo de divisórias | Tamanho máximo da divisória |

|---|---|---|

| Registro de Bota Principal (MBR) | 4 primários, ou 3 primários e 12 lógicos dentro de uma partição estendida | 2TiB |

| Tabela de partição do GUID (GPT) | 128 | 8ZiB |

3.2.3. Partições de disco MBR

Os diagramas deste capítulo mostram a tabela de partição como sendo separada do disco real. No entanto, isto não é totalmente exato. Na realidade, a tabela de partição é armazenada logo no início do disco, antes de qualquer sistema de arquivos ou dados do usuário, mas, para maior clareza, eles estão separados nos diagramas a seguir.

Figura 3.1. Disco com mesa divisória MBR

Como mostra o diagrama anterior, a tabela de partições está dividida em quatro seções de quatro partições primárias. Uma partição primária é uma partição em um disco rígido que pode conter apenas um disco lógico (ou seção). Cada seção pode conter as informações necessárias para definir uma única partição, o que significa que a tabela de partição não pode definir mais do que quatro partições.

Cada entrada da tabela de partição contém várias características importantes da partição:

- Os pontos no disco onde começa e termina a partição.

- Se a divisória é active. Apenas uma partição pode ser sinalizada como active.

- O tipo da divisória.

Os pontos inicial e final definem o tamanho e a localização da partição no disco. A bandeira "ativa" é usada por alguns sistemas operacionais carregadores de inicialização. Em outras palavras, o sistema operacional na partição que está marcado como "ativo" é inicializado, neste caso.

O tipo é um número que identifica o uso antecipado da divisória. Alguns sistemas operacionais usam o tipo de partição para denotar um tipo específico de sistema de arquivo, para marcar a partição como sendo associada a um sistema operacional específico, para indicar que a partição contém um sistema operacional inicializável, ou alguma combinação dos três.

O diagrama a seguir mostra um exemplo de uma unidade com uma única partição:

Figura 3.2. Disco com uma única divisória

A partição única neste exemplo está etiquetada como DOS. Esta etiqueta mostra o tipo de partição, sendo DOS uma das mais comuns.

3.2.4. Partições MBR estendidas

Caso quatro divisórias sejam insuficientes para suas necessidades, você pode usar divisórias estendidas para criar divisórias adicionais. Você pode fazer isso definindo o tipo de partição como "Extendida".

Uma partição estendida é como uma unidade de disco em seu próprio direito - ela tem sua própria tabela de partições, que aponta para uma ou mais partições (agora chamadas partições lógicas, ao contrário das quatro partições primárias), contidas inteiramente dentro da própria partição estendida. O diagrama a seguir mostra um drive de disco com uma partição primária e uma partição estendida contendo duas partições lógicas (juntamente com algum espaço livre não particionado):

Figura 3.3. Disco com uma partição MBR primária e uma MBR estendida

Como este número implica, há uma diferença entre as partições primárias e lógicas - só pode haver até quatro partições primárias e estendidas, mas não há um limite fixo para o número de partições lógicas que podem existir. Entretanto, devido à forma como as partições são acessadas no Linux, não podem ser definidas mais de 15 partições lógicas em um único drive de disco.

3.2.5. Tipos de divisórias MBR

A tabela abaixo mostra uma lista de alguns dos tipos de partição MBR comumente usados e números hexadecimais usados para representá-los.

Tabela 3.2. Tipos de divisórias MBR

| MBR partition type | Value | MBR partition type | Value |

| Vazio | 00 | Novell Netware 386 | 65 |

| DOS 12-bit FAT | 01 | PIC/IX | 75 |

| Raiz XENIX | O2 | Velho MINIX | 80 |

| XENIX usr | O3 | Linux/MINUX | 81 |

| DOS 16 bits ⇐32M | 04 | Troca de Linux | 82 |

| Estendido | 05 | Linux nativo | 83 |

| DOS 16-bit >=32 | 06 | Linux estendido | 85 |

| OS/2 HPFS | 07 | Amoeba | 93 |

| AIX | 08 | Amoeba BBT | 94 |

| AIX inicializável | 09 | BSD/386 | a5 |

| Gerenciador de Boot OS/2 | 0a | OpenBSD | a6 |

| Win95 FAT32 | 0b | NEXTSTEP | a7 |

| Win95 FAT32 (LBA) | 0c | BSDI fs | b7 |

| Win95 FAT16 (LBA) | 0e | Troca de BSDI | b8 |

| Win95 Estendido (LBA) | 0f | Syrinx | c7 |

| Venix 80286 | 40 | CP/M | db |

| Novell | 51 | Acesso DOS | e1 |

| Bota PRep | 41 | DOS R/O | e3 |

| GNU HURD | 63 | DOS secundário | f2 |

| Novell Netware 286 | 64 | BBT | ff |

3.2.6. Tabela de partição do GUID

A Tabela de Partição GUID (GPT) é um esquema de partição baseado no uso de um Identificador Único Global (GUID). O GPT foi desenvolvido para lidar com as limitações da tabela de partição MBR, especialmente com o espaço máximo de armazenamento endereçável limitado de um disco. Ao contrário do MBR, que é incapaz de endereçar armazenamento maior que 2 TiB (equivalente a aproximadamente 2,2 TB), o GPT é usado com discos rígidos maiores que este; o tamanho máximo do disco endereçável é 2,2 ZiB. Além disso, o GPT, por padrão, suporta a criação de até 128 partições primárias. Este número poderia ser ampliado alocando mais espaço para a tabela de partições.

Um GPT tem tipos de divisórias baseadas em GUIDs. Note que certas partições requerem um GUID específico. Por exemplo, a partição do sistema para carregadores de inicialização EFI requer o GUID C12A7328-F81F-11D2-BA4B-00A0C93EC93B.

Os discos GPT usam endereçamento lógico de blocos (LBA) e o layout da partição é o seguinte:

- Para preservar a compatibilidade com os discos MBR, o primeiro setor (LBA 0) do GPT é reservado para os dados MBR e é chamado de "MBR de proteção".

- O cabeçalho GPT primário começa no segundo bloco lógico (LBA 1) do dispositivo. O cabeçalho contém o GUID do disco, a localização da tabela de partição primária, a localização do cabeçalho GPT secundário, e os checksums CRC32 de si mesmo, e a tabela de partição primária. Ele também especifica o número de entradas de partição na tabela.

- O GPT primário inclui, por padrão, 128 entradas de partição, cada uma com um tamanho de entrada de 128 bytes, seu tipo de partição GUID e GUID de partição única.

- O GPT secundário é idêntico ao GPT primário. Ele é usado principalmente como uma tabela de reserva para recuperação no caso da tabela de partição primária estar corrompida.

- O cabeçalho secundário GPT está localizado no último setor lógico do disco e pode ser usado para recuperar informações GPT no caso do cabeçalho primário estar corrompido. Ele contém o GUID do disco, a localização da tabela de partição secundária e do cabeçalho GPT primário, os checksums CRC32 de si mesmo e da tabela de partição secundária, e o número de possíveis entradas de partição.

Figura 3.4. Disco com uma tabela de partição GUID

Deve haver uma partição de inicialização BIOS para que o carregador de inicialização seja instalado com sucesso em um disco que contenha uma GPT (GUID Partition Table). Isto inclui discos inicializados por Anaconda. Se o disco já contém uma partição de inicialização da BIOS, ela pode ser reutilizada.

3.2.7. Criação de uma tabela de partição em um disco com partição

Este procedimento descreve como formatar um dispositivo de bloco com uma tabela de partição usando o utilitário parted.

Procedimento

Inicie o shell interativo

parted:# Separado block-device-

Substitua block-device com o caminho para o dispositivo onde você deseja criar uma tabela de partição: por exemplo,

/dev/sda.

-

Substitua block-device com o caminho para o dispositivo onde você deseja criar uma tabela de partição: por exemplo,

Determinar se já existe uma tabela de partição no dispositivo:

(dividido) impressão

Se o dispositivo já contém partições, elas serão apagadas nas próximas etapas.

Criar a nova mesa divisória:

(separado) mklabel table-typeSubstitua table-type com o tipo de mesa divisória prevista:

-

msdospara MBR -

gptpara GPT

-

Exemplo 3.2. Criação de uma tabela GPT

Por exemplo, para criar uma tabela GPT sobre o disco, use:

(separado) mklabel gpt

As mudanças começam a acontecer assim que você entra neste comando, portanto, revise-o antes de executá-lo.

Veja a tabela de partição para confirmar que a tabela de partição existe:

(dividido) impressão

Saia da casca

parted:(separado) desistir

Recursos adicionais

-

A página do homem

parted(8).

Próximos passos

- Criar divisórias no dispositivo. Veja Seção 3.3, “Criando uma divisória” para detalhes.

3.3. Criando uma divisória

Como administrador do sistema, você pode criar novas partições em um disco.

3.3.1. Considerações antes de modificar as partições em um disco

Esta seção lista os pontos-chave a serem considerados antes de criar, remover ou redimensionar as divisórias.

Esta seção não cobre a tabela de partição DASD, que é específica para a arquitetura IBM Z. Para informações sobre o DASD, veja:

- Configuração de uma instância Linux na IBM Z

- O que você deve saber sobre o artigo DASD no Centro de Conhecimento da IBM

O número máximo de divisórias

O número de divisórias em um dispositivo é limitado pelo tipo da tabela de divisórias:

Em um dispositivo formatado com a tabela de partição Master Boot Record (MBR), você pode ter qualquer um dos dois:

- Até quatro partições primárias, ou

- Até três divisórias primárias, uma divisória estendida, e múltiplas divisórias lógicas dentro da estendida.

-

Em um dispositivo formatado com o GUID Partition Table (GPT), o número máximo de divisórias é de 128. Enquanto a especificação GPT permite mais partições aumentando a área reservada para a tabela de partição, a prática comum usada pelo utilitário

partedé limitá-la a uma área suficiente para 128 partições.

A Red Hat recomenda que, a menos que você tenha uma razão para fazer o contrário, você deve at least criar as seguintes partições: swap, /boot/, e / (raiz).

O tamanho máximo de uma divisória

O tamanho de uma divisória em um dispositivo é limitado pelo tipo da mesa divisória:

- Em um dispositivo formatado com a tabela de partição Master Boot Record (MBR), o tamanho máximo é 2TiB.

- Em um dispositivo formatado com o GUID Partition Table (GPT), o tamanho máximo é 8ZiB.

Se você quiser criar uma partição maior que 2TiB, o disco deve ser formatado com GPT.

Alinhamento de tamanhos

O utilitário parted permite especificar o tamanho da partição usando vários sufixos diferentes:

- MiB, GiB, ou TiB

Tamanho expresso em poderes de 2.

- O ponto de partida da divisória é alinhado ao setor exato especificado por tamanho.

- O ponto final é alinhado com o tamanho especificado menos 1 setor.

- MB, GB, ou TB

Tamanho expresso em poderes de 10.

O ponto inicial e final é alinhado dentro de uma metade da unidade especificada: por exemplo, ±500KB ao utilizar o sufixo MB.

3.3.2. Tipos de partição

Esta seção descreve diferentes atributos que especificam o tipo de uma partição.

Tipos de partição ou bandeiras

O tipo de divisória, ou bandeira, é usado por um sistema em funcionamento apenas raramente. Entretanto, o tipo de partição é importante para os geradores em funcionamento, tais como systemd-gpt-auto-generator, que utilizam o tipo de partição para, por exemplo, identificar e montar automaticamente os dispositivos.

-

O utilitário

partedfornece algum controle dos tipos de partição através do mapeamento do tipo de partição para flags. O utilitário parted pode controlar apenas certos tipos de partição: por exemplo LVM, swap, ou RAID. -

O utilitário

fdisksuporta toda a gama de tipos de divisórias especificando códigos hexadecimais.

Tipo de sistema de arquivo de partição

O utilitário parted aceita opcionalmente um argumento de tipo de sistema de arquivo ao criar uma partição. O valor é usado para:

- Coloque as bandeiras de partição no MBR, ou

-

Defina a partição tipo UUID no GPT. Por exemplo, os tipos de sistema de arquivo

swap,fat, ouhfsdefinem diferentes GUIDs. O valor padrão é o GUID de dados Linux.

O argumento não modifica de forma alguma o sistema de arquivo na partição. Ele apenas diferencia entre as bandeiras ou GUIDs suportadas.

Os seguintes tipos de sistemas de arquivo são suportados:

-

xfs -

ext2 -

ext3 -

ext4 -

fat16 -

fat32 -

hfs -

hfs -

linux-swap -

ntfs -

reiserfs

3.3.3. Esquema de nomenclatura das partições

O Red Hat Enterprise Linux usa um esquema de nomes baseado em arquivos, com nomes de arquivos na forma de /dev/xxyN.

Os nomes dos dispositivos e das divisórias consistem na seguinte estrutura:

/dev/-

Este é o nome do diretório no qual estão localizados todos os arquivos do dispositivo. Como as partições são colocadas em discos rígidos, e os discos rígidos são dispositivos, os arquivos que representam todas as partições possíveis estão localizados em

/dev. xx-

As duas primeiras letras do nome das divisórias indicam o tipo de dispositivo em que se encontra a divisória, geralmente

sd. y-

Esta letra indica em qual dispositivo a divisória está ligada. Por exemplo,

/dev/sdapara o primeiro disco rígido,/dev/sdbpara o segundo, e assim por diante. Em sistemas com mais de 26 drives, é possível usar mais letras. Por exemplo,/dev/sdaa1. N-

A letra final indica o número que representa a partição. As quatro primeiras partições (primárias ou ampliadas) são numeradas

1até4. As partições lógicas começam em5. Por exemplo,/dev/sda3é a terceira partição primária ou estendida no primeiro disco rígido, e/dev/sdb6é a segunda partição lógica no segundo disco rígido. A numeração das partições do disco se aplica somente às tabelas de partições MBR. Observe que N nem sempre significa partição.

Mesmo que o Red Hat Enterprise Linux possa identificar e consultar os tipos de partições de disco all, ele pode não ser capaz de ler o sistema de arquivo e, portanto, acessar os dados armazenados em cada tipo de partição. Entretanto, em muitos casos, é possível acessar com sucesso dados em uma partição dedicada a outro sistema operacional.

3.3.4. Pontos de montagem e partições de disco

No Red Hat Enterprise Linux, cada partição é usada para formar parte do armazenamento necessário para suportar um único conjunto de arquivos e diretórios. Isto é feito usando o processo conhecido como mounting, que associa uma partição a um diretório. A montagem de uma partição torna seu armazenamento disponível a partir do diretório especificado, conhecido como mount point.

Por exemplo, se a partição /dev/sda5 estiver montada em /usr/, isso significaria que todos os arquivos e diretórios sob /usr/ residem fisicamente em /dev/sda5. Assim, o arquivo /usr/share/doc/FAQ/txt/Linux-FAQ seria armazenado em /dev/sda5, enquanto o arquivo /etc/gdm/custom.conf não o seria.

Continuando o exemplo, também é possível que um ou mais diretórios abaixo de /usr/ sejam pontos de montagem para outras partições. Por exemplo, uma partição /dev/sda7 poderia ser montada em /usr/local, o que significa que /usr/local/man/whatis residiria então em /dev/sda7 em vez de /dev/sda5.

3.3.5. Criação de uma divisória com separação

Este procedimento descreve como criar uma nova partição em um dispositivo de bloco usando o utilitário parted.

Pré-requisitos

- Há uma tabela de partição no disco. Para detalhes sobre como formatar o disco, veja Seção 3.2, “Criação de uma tabela de partição em um disco”.

- Se a partição que você deseja criar for maior que 2TiB, o disco deve ser formatado com a Tabela de Partição GUID (GPT).

Procedimento

Inicie o shell interativo

parted:# Separado block-device-

Substitua block-device com o caminho para o dispositivo onde você quer criar uma partição: por exemplo,

/dev/sda.

-

Substitua block-device com o caminho para o dispositivo onde você quer criar uma partição: por exemplo,

Veja a tabela de partição atual para determinar se há espaço livre suficiente:

(dividido) impressão

- Se não houver espaço livre suficiente, você pode redimensionar uma divisória existente. Para mais informações, consulte Seção 3.5, “Redimensionamento de uma divisória”.

A partir da tabela de partição, determine:

- Os pontos de início e fim da nova divisória

- No MBR, que tipo de partição deve ser.

Criar a nova divisória:

(separado) mkpart part-type name fs-type start end

-

Substitua part-type com

primary,logical, ouextendedcom base no que você decidiu a partir da tabela de partição. Isto se aplica somente à tabela de partição MBR. - Substitua name com um nome de partição arbitrária. Isto é necessário para as tabelas de partição GPT.

-

Substitua fs-type com qualquer um de

xfs,ext2,ext3,ext4,fat16,fat32,hfs,hfs,linux-swap,ntfs, oureiserfs. O fs-type parâmetro é opcional. Note quepartednão cria o sistema de arquivo na partição. -

Substitua start e end com os tamanhos que determinam os pontos inicial e final da partição, contando desde o início do disco. Pode-se usar sufixos de tamanho, como

512MiB,20GiB, ou1.5TiB. Os megabytes de tamanho padrão.

Exemplo 3.3. Criação de uma pequena partição primária

Por exemplo, para criar uma partição primária de 1024MiB até 2048MiB em uma tabela MBR, use:

(dividido) mkpart primário 1024MiB 2048MiB

As mudanças começam a acontecer assim que você entra neste comando, portanto, revise-o antes de executá-lo.

-

Substitua part-type com

Veja a tabela de partição para confirmar que a partição criada está na tabela de partição com o tipo, tipo de sistema de arquivo e tamanho corretos:

(dividido) impressão

Saia da casca

parted:(separado) desistir

Use o seguinte comando para esperar que o sistema registre o novo nó de dispositivo:

# udevadm assentar

Verificar se o núcleo reconhece a nova partição:

# gato /proc/partições

Recursos adicionais

-

A página do homem

parted(8).

3.3.6. Definição de um tipo de divisória com fdisk

Este procedimento descreve como definir um tipo de partição, ou bandeira, usando o utilitário fdisk.

Pré-requisitos

- Há uma partição no disco.

Procedimento

Inicie o shell interativo

fdisk:# fdisk block-device-

Substitua block-device com o caminho para o dispositivo onde você quer definir um tipo de partição: por exemplo,

/dev/sda.

-

Substitua block-device com o caminho para o dispositivo onde você quer definir um tipo de partição: por exemplo,

Veja a tabela de partição atual para determinar o número da partição menor:

Comando (m de ajuda) printVocê pode ver o tipo de partição atual na coluna

Typee sua identificação de tipo correspondente na colunaId.Digite o comando tipo de partição e selecione uma partição usando seu número menor:

Command (m for help): type Partition number (1,2,3 default 3): 2

Opcionalmente, liste os códigos hexadecimais disponíveis:

Código hexadecimal (tipo L para listar todos os códigos) LDefina o tipo de divisória:

Código hexadecimal (tipo L para listar todos os códigos) 8eEscreva suas mudanças e saia da casca

fdisk:Command (m for help): write The partition table has been altered. Syncing disks.Verifique suas mudanças:

# fdisk --lista block-device

3.4. Remoção de uma divisória

Como administrador do sistema, você pode remover uma partição de disco que não é mais utilizada para liberar espaço em disco.

A remoção de uma partição apaga todos os dados armazenados na partição.

3.4.1. Considerações antes de modificar as partições em um disco

Esta seção lista os pontos-chave a serem considerados antes de criar, remover ou redimensionar as divisórias.

Esta seção não cobre a tabela de partição DASD, que é específica para a arquitetura IBM Z. Para informações sobre o DASD, veja:

- Configuração de uma instância Linux na IBM Z

- O que você deve saber sobre o artigo DASD no Centro de Conhecimento da IBM

O número máximo de divisórias

O número de divisórias em um dispositivo é limitado pelo tipo da tabela de divisórias:

Em um dispositivo formatado com a tabela de partição Master Boot Record (MBR), você pode ter qualquer um dos dois:

- Até quatro partições primárias, ou

- Até três divisórias primárias, uma divisória estendida, e múltiplas divisórias lógicas dentro da estendida.

-

Em um dispositivo formatado com o GUID Partition Table (GPT), o número máximo de divisórias é de 128. Enquanto a especificação GPT permite mais partições aumentando a área reservada para a tabela de partição, a prática comum usada pelo utilitário

partedé limitá-la a uma área suficiente para 128 partições.

A Red Hat recomenda que, a menos que você tenha uma razão para fazer o contrário, você deve at least criar as seguintes partições: swap, /boot/, e / (raiz).

O tamanho máximo de uma divisória

O tamanho de uma divisória em um dispositivo é limitado pelo tipo da mesa divisória:

- Em um dispositivo formatado com a tabela de partição Master Boot Record (MBR), o tamanho máximo é 2TiB.

- Em um dispositivo formatado com o GUID Partition Table (GPT), o tamanho máximo é 8ZiB.

Se você quiser criar uma partição maior que 2TiB, o disco deve ser formatado com GPT.

Alinhamento de tamanhos

O utilitário parted permite especificar o tamanho da partição usando vários sufixos diferentes:

- MiB, GiB, ou TiB

Tamanho expresso em poderes de 2.

- O ponto de partida da divisória é alinhado ao setor exato especificado por tamanho.

- O ponto final é alinhado com o tamanho especificado menos 1 setor.

- MB, GB, ou TB

Tamanho expresso em poderes de 10.

O ponto inicial e final é alinhado dentro de uma metade da unidade especificada: por exemplo, ±500KB ao utilizar o sufixo MB.

3.4.2. Remoção de uma divisória com separação

Este procedimento descreve como remover uma partição de disco usando o utilitário parted.

Procedimento

Inicie o shell interativo

parted:# Separado block-device-

Substitua block-device com o caminho para o dispositivo onde você quer remover uma partição: por exemplo,

/dev/sda.

-

Substitua block-device com o caminho para o dispositivo onde você quer remover uma partição: por exemplo,

Veja a tabela de partição atual para determinar o número menor da partição a ser removida:

(dividido) impressão

Remover a divisória:

(separados) rm minor-number-

Substitua minor-number com o número menor da partição que você deseja remover: por exemplo,

3.

As mudanças começam a acontecer assim que você entra neste comando, portanto, revise-o antes de executá-lo.

-

Substitua minor-number com o número menor da partição que você deseja remover: por exemplo,

Confirmar que a divisória é removida da mesa divisória:

(dividido) impressão

Saia da casca

parted:(separado) desistir

Verificar se o núcleo sabe que a partição foi removida:

# gato /proc/partições

-

Remova a partição do arquivo

/etc/fstabse ela estiver presente. Encontre a linha que declara a partição removida, e remova-a do arquivo. Regenere as unidades de montagem para que seu sistema registre a nova configuração

/etc/fstab:# systemctl daemon-reload

Se você tiver excluído uma partição swap ou removido pedaços de LVM, remova todas as referências à partição da linha de comando do kernel no arquivo

/etc/default/grube regenere a configuração do GRUB:Em um sistema baseado na BIOS:

# grub2-mkconfig --output=/etc/grub2.cfg

Em um sistema baseado na UEFI:

# grub2-mkconfig --output=/etc/grub2-efi.cfg

Para registrar as mudanças no sistema de inicialização inicial, reconstrua o sistema de arquivos

initramfs:# dracut --force --verbose

Recursos adicionais

-

A página do homem

parted(8)

3.5. Redimensionamento de uma divisória

Como administrador de sistema, você pode estender uma partição para utilizar o espaço não utilizado em disco, ou encolher uma partição para utilizar sua capacidade para diferentes propósitos.

3.5.1. Considerações antes de modificar as partições em um disco

Esta seção lista os pontos-chave a serem considerados antes de criar, remover ou redimensionar as divisórias.

Esta seção não cobre a tabela de partição DASD, que é específica para a arquitetura IBM Z. Para informações sobre o DASD, veja:

- Configuração de uma instância Linux na IBM Z

- O que você deve saber sobre o artigo DASD no Centro de Conhecimento da IBM

O número máximo de divisórias

O número de divisórias em um dispositivo é limitado pelo tipo da tabela de divisórias:

Em um dispositivo formatado com a tabela de partição Master Boot Record (MBR), você pode ter qualquer um dos dois:

- Até quatro partições primárias, ou

- Até três divisórias primárias, uma divisória estendida, e múltiplas divisórias lógicas dentro da estendida.

-

Em um dispositivo formatado com o GUID Partition Table (GPT), o número máximo de divisórias é de 128. Enquanto a especificação GPT permite mais partições aumentando a área reservada para a tabela de partição, a prática comum usada pelo utilitário

partedé limitá-la a uma área suficiente para 128 partições.

A Red Hat recomenda que, a menos que você tenha uma razão para fazer o contrário, você deve at least criar as seguintes partições: swap, /boot/, e / (raiz).

O tamanho máximo de uma divisória

O tamanho de uma divisória em um dispositivo é limitado pelo tipo da mesa divisória:

- Em um dispositivo formatado com a tabela de partição Master Boot Record (MBR), o tamanho máximo é 2TiB.

- Em um dispositivo formatado com o GUID Partition Table (GPT), o tamanho máximo é 8ZiB.

Se você quiser criar uma partição maior que 2TiB, o disco deve ser formatado com GPT.

Alinhamento de tamanhos

O utilitário parted permite especificar o tamanho da partição usando vários sufixos diferentes:

- MiB, GiB, ou TiB

Tamanho expresso em poderes de 2.

- O ponto de partida da divisória é alinhado ao setor exato especificado por tamanho.

- O ponto final é alinhado com o tamanho especificado menos 1 setor.

- MB, GB, ou TB

Tamanho expresso em poderes de 10.

O ponto inicial e final é alinhado dentro de uma metade da unidade especificada: por exemplo, ±500KB ao utilizar o sufixo MB.

3.5.2. Redimensionamento de uma divisória com separação

Este procedimento redimensiona uma partição de disco usando o utilitário parted.

Pré-requisitos

Se você quiser encolher uma partição, faça backup dos dados que estão armazenados nela.

AtençãoRetrair uma partição pode resultar em perda de dados na partição.

- Se você quiser redimensionar uma partição para ser maior que 2TiB, o disco deve ser formatado com a Tabela de Partição GUID (GPT). Para obter detalhes sobre como formatar o disco, consulte Seção 3.2, “Criação de uma tabela de partição em um disco”.

Procedimento

- Se você quiser diminuir a partição, encolha primeiro o sistema de arquivo sobre ela para que não seja maior do que a partição redimensionada. Note que o XFS não suporta o encolhimento.

Inicie o shell interativo

parted:# Separado block-device-

Substitua block-device com o caminho para o dispositivo onde você deseja redimensionar uma partição: por exemplo,

/dev/sda.

-

Substitua block-device com o caminho para o dispositivo onde você deseja redimensionar uma partição: por exemplo,

Veja a tabela de partição atual:

(dividido) impressão

A partir da tabela de partição, determine:

- O número menor da divisória

- A localização da divisória existente e seu novo ponto final após o redimensionamento

Redimensionar a divisória:

(dividido) reizepart minor-number new-end

-

Substitua minor-number com o número menor da partição que você está redimensionando: por exemplo,

3. -

Substitua new-end com o tamanho que determina o novo ponto final da partição redimensionada, contando desde o início do disco. Pode-se usar sufixos de tamanho, como

512MiB,20GiB, ou1.5TiB. O tamanho padrão de megabytes.

Exemplo 3.4. Ampliação de uma divisória

Por exemplo, para estender uma partição localizada no início do disco para ser 2GiB em tamanho, use:

(dividido) resizepart 1 2GiB

As mudanças começam a acontecer assim que você entra neste comando, portanto, revise-o antes de executá-lo.

-

Substitua minor-number com o número menor da partição que você está redimensionando: por exemplo,

Veja a tabela de partição para confirmar que a partição redimensionada está na tabela de partição com o tamanho correto:

(dividido) impressão

Saia da casca

parted:(separado) desistir

Verificar se o núcleo reconhece a nova partição:

# gato /proc/partições

- Se você estender a partição, estenda o sistema de arquivo também sobre ela. Veja (referência) para detalhes.

Recursos adicionais

-

A página do homem

parted(8).

3.6. Estratégias para reparticionar um disco

Há várias maneiras diferentes de repartir um disco. Esta seção discute as seguintes abordagens possíveis:

- Espaço livre não repartido está disponível

- Uma divisória não utilizada está disponível

- Espaço livre em uma divisória usada ativamente está disponível

Observe que esta seção discute os conceitos mencionados anteriormente apenas teoricamente e não inclui nenhuma etapa processual sobre como realizar o reparticionamento de discos passo a passo.

As ilustrações a seguir são simplificadas no interesse da clareza e não refletem o layout exato da partição que você encontra ao instalar efetivamente o Red Hat Enterprise Linux.

3.6.1. Utilização de espaço livre não particionado

Nesta situação, as partições já definidas não abrangem todo o disco rígido, deixando espaço não alocado que não faz parte de nenhuma partição definida. O diagrama a seguir mostra o que isto pode parecer:

Figura 3.5. Disco com espaço livre não particionado

No exemplo anterior, o primeiro diagrama representa um disco com uma partição primária e uma partição indefinida com espaço não alocado, e o segundo diagrama representa um disco com duas partições definidas com espaço alocado.

Um disco rígido não utilizado também se enquadra nesta categoria. A única diferença é que all o espaço não é parte de nenhuma partição definida.

Em qualquer caso, você pode criar as partições necessárias a partir do espaço não utilizado. Este cenário é mais provável para um novo disco. A maioria dos sistemas operacionais pré-instalados são configurados para ocupar todo o espaço disponível em um drive de disco.

3.6.2. Usando o espaço de uma divisória não utilizada

Neste caso, você pode ter uma ou mais divisórias que você não usa mais. O diagrama a seguir ilustra tal situação.

Figura 3.6. Disco com uma divisória não utilizada

No exemplo anterior, o primeiro diagrama representa um disco com uma partição não utilizada, e o segundo diagrama representa a realocação de uma partição não utilizada para o Linux.

Nesta situação, você pode utilizar o espaço alocado para a divisória não utilizada. Você deve apagar a partição e depois criar a(s) partição(ões) Linux apropriada(s) em seu lugar. Você pode apagar a partição não utilizada e criar manualmente novas partições durante o processo de instalação.

3.6.3. Usando o espaço livre de uma divisória ativa

Esta é a situação mais comum. É também a mais difícil de lidar, pois mesmo que você tenha espaço livre suficiente, ele está atualmente alocado a uma divisória que já está em uso. Se você adquiriu um computador com software pré-instalado, o disco rígido muito provavelmente tem uma partição maciça que contém o sistema operacional e os dados.

Além de adicionar um novo disco rígido ao seu sistema, você pode escolher entre repartições destrutivas e não-destrutivas.

3.6.3.1. Repartição destrutiva

Isto elimina a divisória e cria várias menores em seu lugar. Você deve fazer um backup completo porque qualquer dado na partição original é destruído. Crie dois backups, use verificação (se disponível em seu software de backup), e tente ler os dados do backup before apagando a partição.

Se um sistema operacional foi instalado nessa partição, ele deve ser reinstalado se você quiser usar esse sistema também. Esteja ciente de que alguns computadores vendidos com sistemas operacionais pré-instalados podem não incluir a mídia de instalação para reinstalar o sistema operacional original. Você deve verificar se isto se aplica a seu sistema before você destrói sua partição original e sua instalação do sistema operacional.

Após criar uma partição menor para seu sistema operacional existente, você pode reinstalar o software, restaurar seus dados e iniciar sua instalação do Red Hat Enterprise Linux.

Figura 3.7. Ação reparticionadora destrutiva em disco

Qualquer dado anteriormente presente na partição original é perdido.

3.6.3.2. Repartição não-destrutiva

Com o reparticionamento não destrutivo você executa um programa que torna uma grande partição menor sem perder nenhum dos arquivos armazenados naquela partição. Este método é geralmente confiável, mas pode ser muito demorado em grandes unidades.

O processo de reparticionamento não destrutivo é simples e consiste em três etapas:

- Comprimir e fazer backup dos dados existentes

- Redimensionar a divisória existente

- Criar nova(s) divisória(s)

Cada passo é descrito com mais detalhes.

3.6.3.2.1. Compressão de dados existentes

O primeiro passo é comprimir os dados em sua partição existente. A razão para fazer isto é reorganizar os dados para maximizar o espaço livre disponível no "fim" da partição.

Figura 3.8. Compressão em disco

No exemplo anterior, o primeiro diagrama representa o disco antes da compressão, e o segundo diagrama após a compressão.

Este passo é crucial. Sem ela, a localização dos dados poderia impedir que a partição fosse redimensionada na medida desejada. Note que alguns dados não podem ser movidos. Neste caso, isso restringe severamente o tamanho de suas novas partições, e você poderá ser forçado a reparticionar seu disco de forma destrutiva.

3.6.3.2.2. Redimensionamento da divisória existente

A figura a seguir mostra o processo real de redimensionamento. Enquanto o resultado real da operação de redimensionamento varia, dependendo do software utilizado, na maioria dos casos o espaço recém-liberado é utilizado para criar uma partição sem formatação do mesmo tipo da partição original.

Figura 3.9. Redimensionamento da partição em disco

No exemplo anterior, o primeiro diagrama representa a partição antes do redimensionamento, e o segundo diagrama após o redimensionamento.

É importante entender o que o software de redimensionamento que você usa faz com o espaço recém-liberado, para que você possa tomar as medidas apropriadas. No caso ilustrado aqui, seria melhor apagar a nova partição DOS e criar a partição ou partições Linux apropriadas.

3.6.3.2.3. Criação de novas divisórias

Como mencionado no exemplo Redimensionando a partição existente, pode ou não ser necessário criar novas partições. Entretanto, a menos que seu software de redimensionamento suporte sistemas com Linux instalado, é provável que você tenha que apagar a partição que foi criada durante o processo de redimensionamento.

Figura 3.10. Disco com configuração final da divisória

No exemplo anterior, o primeiro diagrama representa o disco antes da configuração, e o segundo diagrama após a configuração.

Capítulo 4. Visão geral dos atributos de nomeação persistentes

Como administrador de sistema, você precisa se referir aos volumes de armazenamento usando atributos de nomes persistentes para construir configurações de armazenamento que sejam confiáveis em várias boots de sistema.

4.1. Desvantagens dos atributos de nomenclatura não-persistentes

O Red Hat Enterprise Linux oferece uma série de maneiras de identificar dispositivos de armazenamento. É importante usar a opção correta para identificar cada dispositivo quando usado a fim de evitar o acesso inadvertido ao dispositivo errado, particularmente ao instalar ou reformatar unidades.

Tradicionalmente, nomes não-persistentes na forma de /dev/sd(major number)(minor number) são usados no Linux para se referir a dispositivos de armazenamento. A faixa de números maiores e menores e os nomes associados a sd são alocados para cada dispositivo quando ele é detectado. Isto significa que a associação entre o intervalo de números maior e menor e os nomes associados sd podem mudar se a ordem de detecção do dispositivo mudar.

Tal mudança no ordenamento pode ocorrer nas seguintes situações:

- A paralelização do processo de inicialização do sistema detecta os dispositivos de armazenamento em uma ordem diferente com cada inicialização do sistema.

-

Um disco não consegue ligar ou responder ao controlador SCSI. Isto faz com que ele não seja detectado pela sonda normal do dispositivo. O disco não é acessível ao sistema e os dispositivos subseqüentes terão sua faixa de maior e menor número, incluindo os nomes associados

sddeslocados para baixo. Por exemplo, se um disco normalmente referido comosdbnão for detectado, um disco que normalmente é referido comosdcapareceria comosdb. -

Um controlador SCSI (host bus adapter, ou HBA) não se inicializa, fazendo com que todos os discos conectados a esse HBA não sejam detectados. A quaisquer discos conectados a HBAs subseqüentemente sondados são atribuídas diferentes faixas de números maiores e menores, e diferentes nomes associados a

sd. - A ordem de inicialização do motorista muda se diferentes tipos de HBAs estiverem presentes no sistema. Isto faz com que os discos conectados a esses HBAs sejam detectados em uma ordem diferente. Isto também pode ocorrer se os HBAs forem movidos para diferentes slots PCI no sistema.

-

Os discos conectados ao sistema com adaptadores Fibre Channel, iSCSI ou FCoE podem estar inacessíveis no momento em que os dispositivos de armazenamento são sondados, devido a uma matriz de armazenamento ou interruptor de intervenção sendo desligado, por exemplo. Isto pode ocorrer quando um sistema é reinicializado após uma falha de energia, se a matriz de armazenamento levar mais tempo para ficar on-line do que o sistema leva para arrancar. Embora alguns drivers Fibre Channel suportem um mecanismo para especificar uma identificação de alvo SCSI persistente para o mapeamento WWPN, isto não faz com que as faixas de números maiores e menores, e os nomes associados

sdsejam reservados; ele só fornece números de identificação de alvo SCSI consistentes.

Estas razões tornam indesejável o uso da faixa de números maiores e menores ou dos nomes associados sd ao se referir aos dispositivos, como no arquivo /etc/fstab. Existe a possibilidade de que o dispositivo errado seja montado e a corrupção de dados possa resultar.

Ocasionalmente, porém, ainda é necessário consultar os nomes sd mesmo quando outro mecanismo é utilizado, como quando são relatados erros por um dispositivo. Isto porque o kernel Linux usa os nomes sd (e também os nomes SCSI host/channel/target/LUN tuples) nas mensagens do kernel referentes ao dispositivo.

4.2. Sistema de arquivos e identificadores de dispositivos

Esta seção explica a diferença entre atributos persistentes que identificam sistemas de arquivos e dispositivos de blocos.

Identificadores do sistema de arquivo

Os identificadores do sistema de arquivo são vinculados a um sistema de arquivo particular criado em um dispositivo de bloco. O identificador também é armazenado como parte do sistema de arquivo. Se você copiar o sistema de arquivo para um dispositivo diferente, ele ainda carrega o mesmo identificador de sistema de arquivo. Por outro lado, se você reescrever o dispositivo, por exemplo, formatando-o com o utilitário mkfs, o dispositivo perde o atributo.

Os identificadores do sistema de arquivo incluem:

- Identificador único (UUID)

- Etiqueta

Identificadores de dispositivos

Os identificadores de dispositivos são vinculados a um dispositivo de bloco: por exemplo, um disco ou uma partição. Se você reescrever o dispositivo, por exemplo, formatando-o com o utilitário mkfs, o dispositivo mantém o atributo, pois ele não é armazenado no sistema de arquivos.

Os identificadores de dispositivos incluem:

- World Wide Identifier (WWID)

- Partição UUID

- Número de série

Recomendações

- Alguns sistemas de arquivo, tais como volumes lógicos, abrangem vários dispositivos. A Red Hat recomenda acessar esses sistemas de arquivo usando identificadores de sistemas de arquivo em vez de identificadores de dispositivos.

4.3. Nomes de dispositivos gerenciados pelo mecanismo udev em /dev/disco/

Esta seção lista diferentes tipos de atributos de nomes persistentes que o serviço udev fornece no diretório /dev/disk/.

O mecanismo udev é usado para todos os tipos de dispositivos no Linux, não apenas para dispositivos de armazenamento. No caso de dispositivos de armazenamento, o Red Hat Enterprise Linux contém udev regras que criam links simbólicos no diretório /dev/disk/. Isto permite que você se refira aos dispositivos de armazenamento por:

- Seu conteúdo

- Um identificador único

- Seu número de série.

Embora os atributos de nomenclatura udev sejam persistentes, na medida em que não mudam por si mesmos através de reinicializações do sistema, alguns também são configuráveis.

4.3.1. Identificadores do sistema de arquivo

O atributo UUID em /dev/disco/by-uuid/

As entradas neste diretório fornecem um nome simbólico que se refere ao dispositivo de armazenamento por um unique identifier (UUID) no conteúdo (ou seja, os dados) armazenados no dispositivo. Por exemplo, o nome do dispositivo:

/dev/disco/by-uuid/3e6be9de-8139-11d1-9106-a43f08d823a6

Você pode usar a UUID para consultar o dispositivo no arquivo /etc/fstab usando a seguinte sintaxe:

UUID=3e6be9de-8139-11d1-9106-a43f08d823a6Você pode configurar o atributo UUID ao criar um sistema de arquivo, e também pode alterá-lo mais tarde.

O atributo Label in /dev/disk/by-label/

As entradas neste diretório fornecem um nome simbólico que se refere ao dispositivo de armazenamento por um label no conteúdo (ou seja, os dados) armazenados no dispositivo.

Por exemplo:

/dev/disco/by-label/Boot

Você pode usar a etiqueta para se referir ao dispositivo no arquivo /etc/fstab usando a seguinte sintaxe:

LABEL=BootVocê pode configurar o atributo Label ao criar um sistema de arquivo, e também pode alterá-lo posteriormente.

4.3.2. Identificadores de dispositivos

O atributo WWID em /dev/disco/by-id/

O World Wide Identifier (WWID) é um persistente, system-independent identifier que a norma SCSI exige de todos os dispositivos SCSI. O identificador WWID é garantido como único para cada dispositivo de armazenamento, e independente do caminho que é usado para acessar o dispositivo. O identificador é uma propriedade do dispositivo, mas não é armazenado no conteúdo (ou seja, os dados) dos dispositivos.

Este identificador pode ser obtido emitindo um SCSI Inquiry para recuperar os Dados Vitais de Identificação do Dispositivo (página 0x83) ou o Número de Série da Unidade (página 0x80).

O Red Hat Enterprise Linux mantém automaticamente o mapeamento adequado do nome do dispositivo baseado na WWID para um nome atual /dev/sd naquele sistema. As aplicações podem usar o nome /dev/disk/by-id/ para referenciar os dados no disco, mesmo que o caminho para o dispositivo mude, e mesmo ao acessar o dispositivo a partir de sistemas diferentes.

Exemplo 4.1. Mapas da WWID

| WWID symlink | Dispositivo não-persistente | Nota |

|---|---|---|

|

|

|

Um dispositivo com uma página |

|

|

|

Um dispositivo com uma página |

|

|

| Uma partição de disco |

Além desses nomes persistentes fornecidos pelo sistema, você também pode usar as regras do udev para implementar nomes persistentes próprios, mapeados para a WWID do armazenamento.

O atributo Partição UUID em /dev/disco/by-partuuid

O atributo Partição UUID (PARTUUID) identifica as partições como definidas pela tabela de partição GPT.

Exemplo 4.2. Mapeamentos de partição UUID

| Link simbólico PARTUÍDO | Dispositivo não-persistente |

|---|---|

|

|

|

|

|

|

|

|

|

O atributo Caminho em /dev/disco/by-path/

Este atributo fornece um nome simbólico que se refere ao dispositivo de armazenamento pelo hardware path usado para acessar o dispositivo.

O atributo Path falha se qualquer parte do caminho do hardware (por exemplo, o PCI ID, porta de destino, ou número LUN) mudar. O atributo Caminho não é, portanto, confiável. Entretanto, o atributo Caminho pode ser útil em um dos seguintes cenários:

- Você precisa identificar um disco que está planejando substituir mais tarde.

- Você planeja instalar um serviço de armazenamento em um disco em um local específico.

4.4. O identificador mundial com DM Multipath

Esta seção descreve o mapeamento entre o World Wide Identifier (WWID) e os nomes de dispositivos não persistentes em uma configuração Multipath Mapper Device Mapper.