Red Hat Training

A Red Hat training course is available for RHEL 8

Managing, monitoring, and updating the kernel

Um guia para gerenciar o kernel do Linux no Red Hat Enterprise Linux 8

Resumo

Tornando o código aberto mais inclusivo

A Red Hat tem o compromisso de substituir a linguagem problemática em nosso código, documentação e propriedades da web. Estamos começando com estes quatro termos: master, slave, blacklist e whitelist. Por causa da enormidade deste esforço, estas mudanças serão implementadas gradualmente ao longo de vários lançamentos futuros. Para mais detalhes, veja a mensagem de nosso CTO Chris Wright.

Fornecendo feedback sobre a documentação da Red Hat

Agradecemos sua contribuição em nossa documentação. Por favor, diga-nos como podemos melhorá-la. Para fazer isso:

Para comentários simples sobre passagens específicas:

- Certifique-se de que você está visualizando a documentação no formato Multi-page HTML. Além disso, certifique-se de ver o botão Feedback no canto superior direito do documento.

- Use o cursor do mouse para destacar a parte do texto que você deseja comentar.

- Clique no pop-up Add Feedback que aparece abaixo do texto destacado.

- Siga as instruções apresentadas.

Para enviar comentários mais complexos, crie um bilhete Bugzilla:

- Ir para o site da Bugzilla.

- Como Componente, use Documentation.

- Preencha o campo Description com sua sugestão de melhoria. Inclua um link para a(s) parte(s) relevante(s) da documentação.

- Clique em Submit Bug.

Capítulo 1. O RPM do kernel Linux

As seções seguintes descrevem o pacote RPM do kernel Linux fornecido e mantido pela Red Hat.

1.1. O que é um RPM

Um pacote RPM é um arquivo contendo outros arquivos e seus metadados (informações sobre os arquivos que são necessários ao sistema).

Especificamente, um pacote de RPM consiste no arquivo cpio.

O arquivo cpio contém:

- Arquivos

Cabeçalho RPM (metadados do pacote)

O gerenciador de pacotes

rpmutiliza estes metadados para determinar as dependências, onde instalar arquivos e outras informações.

Tipos de pacotes de RPM

Há dois tipos de pacotes de RPM. Ambos os tipos compartilham o formato do arquivo e as ferramentas, mas têm conteúdos diferentes e servem a propósitos diferentes:

Fonte RPM (SRPM)

Um SRPM contém o código fonte e um arquivo SPEC, que descreve como construir o código fonte em um RPM binário. Opcionalmente, os patches para o código-fonte também são incluídos.

RPM Binário

Um RPM binário contém os binários construídos a partir das fontes e remendos.

1.2. A visão geral do pacote RPM do kernel Linux

O kernel RPM é um meta pacote que não contém nenhum arquivo, mas assegura que os seguintes sub-pacotes estejam devidamente instalados:

-

kernel-core- contém um número mínimo de módulos de kernel necessários para a funcionalidade central. Este sub-pacote sozinho poderia ser usado em ambientes virtualizados e em nuvem para fornecer um kernel Red Hat Enterprise Linux 8 com um tempo de inicialização rápido e um tamanho de disco pequeno. -

kernel-modules- contém outros módulos do kernel. -

kernel-modules-extra- contém módulos de kernel para hardware raro.

O pequeno conjunto de sub-pacotes kernel acima visa fornecer uma superfície de manutenção reduzida aos administradores de sistemas, especialmente em ambientes virtualizados e nebulosos.

Os outros pacotes de kernel comuns são, por exemplo:

-

kernel-debug- Contém um kernel com numerosas opções de depuração habilitadas para o diagnóstico do kernel, às custas de um desempenho reduzido. -

kernel-tools- Contém ferramentas para manipular o kernel Linux e documentação de suporte. -

kernel-devel- Contém os cabeçalhos e os arquivos de kernel suficientes para construir módulos contra o pacotekernel. -

kernel-abi-whitelists- Contém informações relativas ao kernel ABI do Red Hat Enterprise Linux, incluindo uma lista de símbolos do kernel que são necessários para os módulos externos do kernel Linux e um plug-inyumpara ajudar na fiscalização. -

kernel-headers- Inclui os arquivos de cabeçalho C que especificam a interface entre o kernel Linux e as bibliotecas e programas de espaço do usuário. Os arquivos de cabeçalho definem estruturas e constantes que são necessárias para a construção da maioria dos programas padrão.

1.3. Exibição do conteúdo do pacote do kernel

O procedimento seguinte descreve como visualizar o conteúdo do pacote do kernel e seus sub-pacotes sem instalá-los usando o comando rpm.

Pré-requisitos

-

Obtido

kernel,kernel-core,kernel-modules,kernel-modules-extraPacotes de RPM para sua arquitetura de CPU

Procedimento

Listar módulos para

kernel:$ rpm -qlp <kernel_rpm>(contains no files) …Listar módulos para

kernel-core:$ rpm -qlp <kernel-core_rpm>… /lib/modules/4.18.0-80.el8.x86_64/kernel/fs/udf/udf.ko.xz /lib/modules/4.18.0-80.el8.x86_64/kernel/fs/xfs /lib/modules/4.18.0-80.el8.x86_64/kernel/fs/xfs/xfs.ko.xz /lib/modules/4.18.0-80.el8.x86_64/kernel/kernel /lib/modules/4.18.0-80.el8.x86_64/kernel/kernel/trace /lib/modules/4.18.0-80.el8.x86_64/kernel/kernel/trace/ring_buffer_benchmark.ko.xz /lib/modules/4.18.0-80.el8.x86_64/kernel/lib /lib/modules/4.18.0-80.el8.x86_64/kernel/lib/cordic.ko.xz …Listar módulos para

kernel-modules:$ rpm -qlp <kernel-modules_rpm>… /lib/modules/4.18.0-80.el8.x86_64/kernel/drivers/infiniband/hw/mlx4/mlx4_ib.ko.xz /lib/modules/4.18.0-80.el8.x86_64/kernel/drivers/infiniband/hw/mlx5/mlx5_ib.ko.xz /lib/modules/4.18.0-80.el8.x86_64/kernel/drivers/infiniband/hw/qedr/qedr.ko.xz /lib/modules/4.18.0-80.el8.x86_64/kernel/drivers/infiniband/hw/usnic/usnic_verbs.ko.xz /lib/modules/4.18.0-80.el8.x86_64/kernel/drivers/infiniband/hw/vmw_pvrdma/vmw_pvrdma.ko.xz …Listar módulos para

kernel-modules-extra:$ rpm -qlp <kernel-modules-extra_rpm>… /lib/modules/4.18.0-80.el8.x86_64/extra/net/sched/sch_cbq.ko.xz /lib/modules/4.18.0-80.el8.x86_64/extra/net/sched/sch_choke.ko.xz /lib/modules/4.18.0-80.el8.x86_64/extra/net/sched/sch_drr.ko.xz /lib/modules/4.18.0-80.el8.x86_64/extra/net/sched/sch_dsmark.ko.xz /lib/modules/4.18.0-80.el8.x86_64/extra/net/sched/sch_gred.ko.xz …

Recursos adicionais

-

Para informações sobre como usar o comando

rpmemkernelRPM já instalado, incluindo seus sub-pacotes, consulte a página do manualrpm(8). - Introdução a RPM packages

Capítulo 2. Atualização do kernel com yum

As seções seguintes trazem informações sobre o kernel Linux fornecido e mantido pela Red Hat (kernel da Red Hat), e como manter o kernel da Red Hat atualizado. Como conseqüência, o sistema operacional terá todas as últimas correções de bugs, melhorias de desempenho e patches, garantindo compatibilidade com novos hardwares.

2.1. O que é o cerne

O kernel é uma parte central de um sistema operacional Linux, que gerencia os recursos do sistema, e fornece interface entre aplicações de hardware e software. O kernel da Red Hat é um kernel personalizado baseado no kernel da linha principal do upstream Linux que os engenheiros da Red Hat desenvolvem e endurecem com foco na estabilidade e compatibilidade com as mais recentes tecnologias e hardware.

Antes que a Red Hat lance uma nova versão do kernel, o kernel precisa passar por um conjunto de rigorosos testes de garantia de qualidade.

Os núcleos da Red Hat são embalados no formato RPM para que sejam fáceis de serem atualizados e verificados pelo yum gerente de pacotes.

Os núcleos que não foram compilados pela Red Hat são not suportados pela Red Hat.

2.2. O que é yum

Esta seção se refere à descrição do yum package manager.

Recursos adicionais

-

Para mais informações em

yum, veja as seções relevantes de Configuring basic system settings.

2.3. Atualização do miolo

O procedimento a seguir descreve como atualizar o kernel usando o yum gerente de pacotes.

Procedimento

Para atualizar o kernel, use o seguinte:

# yum update kernelEste comando atualiza o kernel junto com todas as dependências para a última versão disponível.

- Reinicie seu sistema para que as mudanças entrem em vigor.

Ao atualizar do Red Hat Enterprise Linux 7 para o Red Hat Enterprise Linux 8, siga as seções relevantes do Upgrading from RHEL 7 to RHEL 8 documento.

2.4. Instalando o miolo

O seguinte procedimento descreve como instalar novos núcleos utilizando o yum gerente de pacotes.

Procedimento

Para instalar uma versão específica do kernel, use o seguinte:

# yum install kernel-{version}

Recursos adicionais

- Para uma lista dos grãos disponíveis, consulte Red Hat Code Browser.

- Para uma lista de datas de lançamento de versões específicas do kernel, veja this article.

Capítulo 3. Gerenciando módulos do núcleo

As seções seguintes explicam o que são módulos do kernel, como exibir suas informações e como realizar tarefas administrativas básicas com módulos do kernel.

3.1. Introdução aos módulos do kernel

O kernel do Red Hat Enterprise Linux pode ser estendido com partes adicionais opcionais de funcionalidade, chamadas módulos do kernel, sem a necessidade de reiniciar o sistema. No Red Hat Enterprise Linux 8, os módulos do kernel são código de kernel extra que é embutido em arquivos objetos comprimidos <KERNEL_MODULE_NAME>.ko.xz.

As funcionalidades mais comuns habilitadas pelos módulos do kernel são:

- Driver de dispositivo que adiciona suporte para novo hardware

-

Suporte para um sistema de arquivo como

GFS2ouNFS - Chamadas de sistema

Em sistemas modernos, os módulos do kernel são automaticamente carregados quando necessário. Entretanto, em alguns casos, é necessário carregar ou descarregar os módulos manualmente.

Como o próprio núcleo, os módulos podem tomar parâmetros que personalizam seu comportamento, se necessário.

São fornecidas ferramentas para inspecionar quais módulos estão funcionando atualmente, quais módulos estão disponíveis para carregar no kernel e quais parâmetros um módulo aceita. O ferramental também fornece um mecanismo para carregar e descarregar módulos do kernel para o kernel em execução.

3.2. Introdução à especificação do carregador de inicialização

A Especificação BootLoader (BLS) define um esquema e o formato de arquivo para gerenciar a configuração do bootloader para cada opção de boot no diretório drop-in sem a necessidade de manipular os arquivos de configuração do bootloader. Ao contrário das abordagens anteriores, cada entrada de boot é agora representada por um arquivo de configuração separado no diretório drop-in. O diretório suspenso estende sua configuração sem ter a necessidade de editar ou regenerar os arquivos de configuração. O BLS estende este conceito para as entradas do menu de inicialização.

Usando o BLS, você pode gerenciar as opções do menu bootloader adicionando, removendo ou editando arquivos individuais de entrada de boot em um diretório. Isto torna o processo de instalação do kernel significativamente mais simples e consistente entre as diferentes arquiteturas.

A ferramenta grubby é um roteiro de embalagem fina em torno do BLS e suporta os mesmos argumentos e opções grubby. Ela roda o dracut para criar uma imagem inicial do ramdisk. Com esta configuração, os arquivos de configuração do núcleo do bootloader são estáticos e não são modificados após a instalação do kernel.

Esta premissa é particularmente relevante no Red Hat Enterprise Linux 8 porque o mesmo bootloader não é usado em todas as arquiteturas. GRUB2 é usado na maioria delas como o ARM de 64 bits, mas variantes poucoendianas do IBM Power Systems com camada aberta de abstração de energia (OPAL) usa Petitboot e a arquitetura IBM Z usa zipl.

Recursos adicionais

-

Para mais informações sobre a utilidade

grubby, veja O que é grubby. - Para mais detalhes sobre as entradas de inicialização, veja O que são entradas de inicialização

-

Para mais detalhes, consulte a página do manual

grubby(8).

3.3. Dependências do módulo Kernel

Certos módulos do núcleo às vezes dependem de um ou mais outros módulos do núcleo. O arquivo /lib/modules/<KERNEL_VERSION>/modules.dep contém uma lista completa das dependências dos módulos do kernel para a respectiva versão do kernel.

O arquivo de dependência é gerado pelo programa depmod, que é uma parte do pacote kmod. Muitas das utilidades fornecidas por kmod levam em conta as dependências dos módulos ao realizar operações, de modo que raramente é necessário o rastreamento de dependência manual.

O código dos módulos do kernel é executado no kernel-space no modo irrestrito. Por causa disso, você deve estar atento a quais módulos você está carregando.

Recursos adicionais

-

Para mais informações sobre

/lib/modules/<KERNEL_VERSION>/modules.dep, consulte a página do manualmodules.dep(5). -

Para mais detalhes, incluindo a sinopse e as opções de

depmod, consulte a página do manualdepmod(8).

3.4. Listagem dos módulos do kernel atualmente carregados

O procedimento seguinte descreve como visualizar os módulos do kernel atualmente carregados.

Pré-requisitos

-

O pacote

kmodestá instalado.

Procedimento

Para listar todos os módulos do kernel atualmente carregados, execute:

$ lsmod Module Size Used by fuse 126976 3 uinput 20480 1 xt_CHECKSUM 16384 1 ipt_MASQUERADE 16384 1 xt_conntrack 16384 1 ipt_REJECT 16384 1 nft_counter 16384 16 nf_nat_tftp 16384 0 nf_conntrack_tftp 16384 1 nf_nat_tftp tun 49152 1 bridge 192512 0 stp 16384 1 bridge llc 16384 2 bridge,stp nf_tables_set 32768 5 nft_fib_inet 16384 1 …No exemplo acima:

- A primeira coluna fornece o names dos módulos atualmente carregados.

- A segunda coluna exibe a quantidade de memory por módulo em quilobytes.

- A última coluna mostra o número e, opcionalmente, os nomes dos módulos que são dependent em um determinado módulo.

Recursos adicionais

-

Para mais informações sobre

kmod, consulte o arquivo/usr/share/doc/kmod/READMEou a página do manuallsmod(8).

3.5. Listagem de todos os kernels instalados

O procedimento seguinte descreve como usar a ferramenta de linha de comando grubby para listar as entradas de inicialização GRUB2.

Procedimento

Para listar as entradas de inicialização do kernel:

Para listar as entradas de inicialização do kernel, execute:

# grubby --info=ALL | grep titleO comando exibe as entradas de inicialização do kernel. O campo

kernelmostra o caminho do kernel.O procedimento seguinte descreve como usar o utilitário

grubbypara listar todos os kernels instalados em seus sistemas usando a linha de comando do kernel.

Como exemplo, considere listar grubby-8.40-17, a partir do menu Grub2, tanto nas instalações BLS quanto nas não-BLS.

Procedimento

Para listar todos os módulos de kernel instalados:

Executar o seguinte comando:

# grubby --info=ALL | grep titleA lista de todos os kernels instalados é exibida da seguinte forma:

title=Red Hat Enterprise Linux (4.18.0-20.el8.x86_64) 8.0 (Ootpa) title=Red Hat Enterprise Linux (4.18.0-19.el8.x86_64) 8.0 (Ootpa) title=Red Hat Enterprise Linux (4.18.0-12.el8.x86_64) 8.0 (Ootpa) title=Red Hat Enterprise Linux (4.18.0) 8.0 (Ootpa) title=Red Hat Enterprise Linux (0-rescue-2fb13ddde2e24fde9e6a246a942caed1) 8.0 (Ootpa)

A saída acima mostra a lista de todos os kernels instalados para grubby-8.40-17, usando o menu Grub2.

3.6. Definir um kernel como padrão

O procedimento seguinte descreve como definir um kernel específico como padrão usando a ferramenta de linha de comando grubby e GRUB2.

Procedimento

- Configurando o kernel como padrão, usando a ferramenta

grubby -

Execute o seguinte comando para definir o kernel como padrão usando a ferramenta

grubby:

# grubby --set-default $kernel_pathO comando usa uma identificação de máquina sem o sufixo

.confcomo argumento.NotaA identificação da máquina está localizada no diretório

/boot/loader/entries/.-

Execute o seguinte comando para definir o kernel como padrão usando a ferramenta

- Definindo o kernel como padrão, usando o argumento

id -

Liste as entradas de inicialização usando o argumento

ide, em seguida, defina um kernel pretendido como padrão:

# grubby --info ALL | grep id # grubby --set-default /boot/vmlinuz-<version>.<architecture>

NotaPara listar as entradas de inicialização usando o argumento

title, execute o# grubby --info=ALL | grep titlecomando.-

Liste as entradas de inicialização usando o argumento

- Configurando o kernel padrão apenas para o próximo boot

-

Execute o seguinte comando para definir o kernel padrão apenas para a próxima reinicialização usando o comando

grub2-reboot:

# grub2-reboot <index|title|id>AtençãoDefina com cuidado o kernel padrão para apenas o próximo boot. A instalação de novos kernel RPM's, kernels auto-construídos e a adição manual das entradas no diretório

/boot/loader/entries/podem alterar os valores do índice.-

Execute o seguinte comando para definir o kernel padrão apenas para a próxima reinicialização usando o comando

3.7. Exibição de informações sobre os módulos do kernel

Ao trabalhar com um módulo de kernel, você pode querer ver mais informações sobre esse módulo. Este procedimento descreve como exibir informações extras sobre os módulos do kernel.

Pré-requisitos

-

O pacote

kmodestá instalado.

Procedimento

Para exibir informações sobre qualquer módulo do kernel, execute:

$ modinfo <KERNEL_MODULE_NAME> For example: $ modinfo virtio_net filename: /lib/modules/4.18.0-94.el8.x86_64/kernel/drivers/net/virtio_net.ko.xz license: GPL description: Virtio network driver rhelversion: 8.1 srcversion: 2E9345B281A898A91319773 alias: virtio:d00000001v* depends: net_failover intree: Y name: virtio_net vermagic: 4.18.0-94.el8.x86_64 SMP mod_unload modversions … parm: napi_weight:int parm: csum:bool parm: gso:bool parm: napi_tx:bool

O comando

modinfoexibe algumas informações detalhadas sobre o módulo de kernel especificado. Você pode consultar informações sobre todos os módulos disponíveis, independentemente de estarem ou não carregados. As entradasparmmostram parâmetros que o usuário é capaz de definir para o módulo, e que tipo de valor eles esperam.NotaAo inserir o nome de um módulo de kernel, não anexe a extensão

.ko.xzao final do nome. Os nomes dos módulos do kernel não têm extensões; seus arquivos correspondentes têm.

Recursos adicionais

-

Para mais informações sobre o

modinfo, consulte a página do manualmodinfo(8).

3.8. Carregamento de módulos do núcleo em tempo de execução do sistema

A maneira ideal de expandir a funcionalidade do kernel Linux é carregando módulos do kernel. O procedimento seguinte descreve como usar o comando modprobe para encontrar e carregar um módulo do kernel no kernel atualmente em execução.

Pré-requisitos

- Permissões de raiz

-

O pacote

kmodestá instalado. - O respectivo módulo do núcleo não é carregado. Para garantir que este seja o caso, liste os módulos do kernel carregados.

Procedimento

Selecione um módulo de kernel que você deseja carregar.

Os módulos estão localizados no diretório

/lib/modules/$(uname -r)/kernel/<SUBSYSTEM>/.Carregar o módulo de núcleo relevante:

# modprobe <MODULE_NAME>NotaAo inserir o nome de um módulo de kernel, não anexe a extensão

.ko.xzao final do nome. Os nomes dos módulos do kernel não têm extensões; seus arquivos correspondentes têm.Opcionalmente, verifique se o módulo relevante foi carregado:

$ lsmod | grep <MODULE_NAME>Se o módulo foi carregado corretamente, este comando exibe o módulo do kernel relevante. Por exemplo:

$ lsmod | grep serio_raw serio_raw 16384 0

As mudanças descritas neste procedimento will not persist após reiniciar o sistema.

Recursos adicionais

-

Para mais detalhes sobre

modprobe, consulte a página do manualmodprobe(8).

3.9. Descarga de módulos do núcleo em tempo de execução do sistema

S vezes, você descobre que precisa descarregar certos módulos do kernel em execução. O procedimento seguinte descreve como usar o comando modprobe para encontrar e descarregar um módulo do kernel em tempo de execução do sistema a partir do kernel atualmente carregado.

Pré-requisitos

- Permissões de raiz

-

O pacote

kmodestá instalado.

Procedimento

Execute o comando

lsmode selecione um módulo do kernel que você deseja descarregar.Se um módulo de kernel tiver dependências, descarregue-as antes de descarregar o módulo de kernel. Para detalhes sobre a identificação de módulos com dependências, veja Seção 3.4, “Listagem dos módulos do kernel atualmente carregados”.

Descarregar o módulo do núcleo relevante:

# modprobe -r <MODULE_NAME>Ao inserir o nome de um módulo de kernel, não anexe a extensão

.ko.xzao final do nome. Os nomes dos módulos do kernel não têm extensões; seus arquivos correspondentes têm.AtençãoNão descarregue os módulos do núcleo quando eles são utilizados pelo sistema em execução. Isso pode levar a um sistema instável ou não-operacional.

Opcionalmente, verificar se o módulo relevante foi descarregado:

$ lsmod | grep <MODULE_NAME>Se o módulo foi descarregado com sucesso, este comando não exibe nenhuma saída.

Após terminar este procedimento, os módulos do kernel que são definidos para serem carregados automaticamente na inicialização, will not stay unloaded após reiniciar o sistema. Para informações sobre como combater este resultado, veja Prevenir que os módulos do kernel sejam carregados automaticamente no momento da inicialização do sistema.

Recursos adicionais

-

Para mais detalhes sobre

modprobe, consulte a página do manualmodprobe(8).

3.10. Carregamento automático dos módulos do núcleo no momento da inicialização do sistema

O procedimento a seguir descreve como configurar um módulo de kernel para que ele seja carregado automaticamente durante o processo de inicialização.

Pré-requisitos

- Permissões de raiz

-

O pacote

kmodestá instalado.

Procedimento

Selecione um módulo de kernel que você deseja carregar durante o processo de inicialização.

Os módulos estão localizados no diretório

/lib/modules/$(uname -r)/kernel/<SUBSYSTEM>/.Criar um arquivo de configuração para o módulo:

# echo <MODULE_NAME> > /etc/modules-load.d/<MODULE_NAME>.confNotaAo inserir o nome de um módulo de kernel, não anexe a extensão

.ko.xzao final do nome. Os nomes dos módulos do kernel não têm extensões; seus arquivos correspondentes têm.Opcionalmente, após a reinicialização, verificar se o módulo relevante foi carregado:

$ lsmod | grep <MODULE_NAME>O comando de exemplo acima deve ser bem sucedido e exibir o módulo de kernel relevante.

As mudanças descritas neste procedimento will persist após reiniciar o sistema.

Recursos adicionais

-

Para mais detalhes sobre o carregamento de módulos do kernel durante o processo de inicialização, consulte a página do manual

modules-load.d(5).

3.11. Impedir que os módulos do núcleo sejam carregados automaticamente no momento da inicialização do sistema

O procedimento seguinte descreve como adicionar um módulo de kernel a um denilista para que ele não seja carregado automaticamente durante o processo de inicialização.

Pré-requisitos

- Permissões de raiz

-

O pacote

kmodestá instalado. - Certifique-se de que um módulo do núcleo em um denilista não seja vital para a configuração atual de seu sistema.

Procedimento

Selecione um módulo do núcleo que você deseja colocar em um denilista:

$ lsmod Module Size Used by fuse 126976 3 xt_CHECKSUM 16384 1 ipt_MASQUERADE 16384 1 uinput 20480 1 xt_conntrack 16384 1 …O comando

lsmodexibe uma lista de módulos carregados para o kernel atualmente em execução.Alternativamente, identifique um módulo de kernel descarregado que você deseja evitar de carregar potencialmente.

Todos os módulos do kernel estão localizados no diretório

/lib/modules/<KERNEL_VERSION>/kernel/<SUBSYSTEM>/.

Criar um arquivo de configuração para um denilista:

# vim /etc/modprobe.d/blacklist.conf # Blacklists <KERNEL_MODULE_1> blacklist <MODULE_NAME_1> install <MODULE_NAME_1> /bin/false # Blacklists <KERNEL_MODULE_2> blacklist <MODULE_NAME_2> install <MODULE_NAME_2> /bin/false # Blacklists <KERNEL_MODULE_n> blacklist <MODULE_NAME_n> install <MODULE_NAME_n> /bin/false …

O exemplo mostra o conteúdo do arquivo

blacklist.conf, editado pelo editorvim. A linhablacklistgarante que o módulo do kernel relevante não será carregado automaticamente durante o processo de inicialização. O comandoblacklist, entretanto, não impede que o módulo seja carregado como uma dependência para outro módulo do kernel que não esteja em um denylist. Portanto, a linhainstallfaz com que o/bin/falseseja executado ao invés de instalar um módulo.As linhas que começam com um sinal de hash são comentários para tornar o arquivo mais legível.

NotaAo inserir o nome de um módulo de kernel, não anexe a extensão

.ko.xzao final do nome. Os nomes dos módulos do kernel não têm extensões; seus arquivos correspondentes têm.Criar uma cópia de segurança da imagem inicial do ramdisk atual antes de reconstruir:

# cp /boot/initramfs-$(uname -r).img /boot/initramfs-$(uname -r).bak.$(date %m-\r%H%M%S).imgO comando acima cria uma imagem de backup

initramfscaso a nova versão tenha um problema inesperado.Alternativamente, crie uma cópia de segurança de outra imagem ramdisk inicial que corresponda à versão do kernel para a qual você deseja colocar os módulos do kernel em um denylist:

# cp /boot/initramfs-<SOME_VERSION>.img /boot/initramfs-<SOME_VERSION>.img.bak.$(date %m-\r%H%M%S)

Gerar uma nova imagem ramdisk inicial para refletir as mudanças:

# dracut -f -vSe você estiver construindo uma imagem ramdisk inicial para uma versão do kernel diferente da que você está inicializando atualmente, especifique tanto a versão alvo

initramfsquanto a versão do kernel:# dracut -f -v /boot/initramfs-<TARGET_VERSION>.img <CORRESPONDING_TARGET_KERNEL_VERSION>

Reinicie o sistema:

$ reboot

As mudanças descritas neste procedimento will take effect and persist após reiniciar o sistema. Se você colocar inadequadamente um módulo chave do núcleo em um denylist, você pode enfrentar um sistema instável ou não operacional.

Recursos adicionais

-

Para mais detalhes sobre a utilidade

dracut, consulte a página do manualdracut(8).

3.12. Assinatura de módulos de kernel para inicialização segura

Você pode aumentar a segurança de seu sistema usando módulos de kernel assinados. As seções seguintes descrevem como autoassinar módulos de kernel privados para uso com o RHEL 8 em sistemas de construção baseados em UEFI onde o Secure Boot está habilitado. Estas seções também fornecem uma visão geral das opções disponíveis para importar sua chave pública para um sistema alvo onde você deseja implantar seus módulos do kernel.

Para assinar e carregar módulos do núcleo, você precisa:

Se a inicialização segura for ativada, os carregadores de inicialização do sistema operacional UEFI, o kernel do Red Hat Enterprise Linux e todos os módulos do kernel devem ser assinados com uma chave privada e autenticados com a chave pública correspondente. Se eles não forem assinados e autenticados, o sistema não terá permissão para terminar o processo de inicialização.

A distribuição RHEL 8 inclui:

- Carregadores de inicialização assinados

- Caroços assinados

- Módulos de kernel assinados

Além disso, o carregador de inicialização assinado no primeiro estágio e o kernel assinado incluem chaves públicas da Red Hat embutidas. Estes binários executáveis assinados e chaves incorporadas permitem que a RHEL 8 instale, inicialize e execute com as chaves da Microsoft UEFI Secure Boot Certification Authority que são fornecidas pelo firmware UEFI em sistemas que suportam o UEFI Secure Boot. Note que nem todos os sistemas baseados em UEFI incluem suporte para Inicialização Segura.

Pré-requisitos

Para poder assinar módulos de kernel construídos externamente, instale as utilidades listadas na tabela a seguir no sistema de construção.

Tabela 3.1. Utilidades requeridas

| Utilitário | Fornecido por pacote | Usado em | Objetivo |

|---|---|---|---|

|

|

| Construir sistema | Gera o par de chaves públicas e privadas X.509 |

|

|

| Construir sistema | Arquivo executável utilizado para assinar um módulo de kernel com a chave privada |

|

|

| Sistema alvo | Utilitário opcional usado para cadastrar manualmente a chave pública |

|

|

| Sistema alvo | Utilitário opcional usado para exibir chaves públicas no chaveiro do sistema |

O sistema de construção, onde você constrói e assina seu módulo de kernel, não precisa ter o UEFI Secure Boot habilitado e não precisa sequer ser um sistema baseado no UEFI.

3.12.1. Autenticação de módulos de kernel com chaves X.509

No RHEL 8, quando um módulo do kernel é carregado, o kernel verifica a assinatura do módulo contra as chaves públicas X.509 do chaveiro do sistema do kernel (.builtin_trusted_keys) e do chaveiro da plataforma do kernel (.platform). O chaveiro .platform contém chaves de provedores de plataformas de terceiros e chaves públicas personalizadas. As chaves do sistema do kernel .blacklist são excluídas da verificação. As seções seguintes fornecem uma visão geral das fontes de chaves, chaveiros e exemplos de chaves carregadas de diferentes fontes no sistema. Além disso, você pode ver como autenticar um módulo do kernel.

3.12.1.1. Requisitos de autenticação

Você precisa atender a certas condições para carregar módulos do núcleo em sistemas com a funcionalidade UEFI Secure Boot habilitada.

Se o UEFI Secure Boot estiver ativado ou se o parâmetro do kernel module.sig_enforce tiver sido especificado:

-

Você só pode carregar aqueles módulos de kernel assinados cujas assinaturas foram autenticadas contra chaves do chaveiro do sistema (

.builtin_trusted_keys) e do chaveiro da plataforma (.platform). -

A chave pública não deve estar no chaveiro revogado do sistema (

.blacklist).

Se o UEFI Secure Boot estiver desativado e o parâmetro do kernel module.sig_enforce não tiver sido especificado:

- Você pode carregar módulos kernel não assinados e módulos kernel assinados sem uma chave pública.

Se o sistema não for baseado na UEFI ou se a UEFI Secure Boot estiver desativada:

-

Apenas as chaves embutidas no kernel são carregadas em

.builtin_trusted_keyse.platform. - Você não tem a capacidade de aumentar esse conjunto de chaves sem reconstruir o núcleo.

Tabela 3.2. Requisitos de autenticação do módulo Kernel para carregamento

| Módulo assinado | Chave pública encontrada e assinatura válida | UEFI Secure Boot state | sig_enforce | Carga do módulo | Núcleo manchado |

|---|---|---|---|---|---|

| Não assinado | - | Não habilitado | Não habilitado | Sucesso | Sim |

| Não habilitado | Habilitado | Falhas | - | ||

| Habilitado | - | Falhas | - | ||

| Assinado | Não | Não habilitado | Não habilitado | Sucesso | Sim |

| Não habilitado | Habilitado | Falhas | - | ||

| Habilitado | - | Falhas | - | ||

| Assinado | Sim | Não habilitado | Não habilitado | Sucesso | Não |

| Não habilitado | Habilitado | Sucesso | Não | ||

| Habilitado | - | Sucesso | Não |

3.12.1.2. Fontes para chaves públicas

Durante a inicialização, o núcleo carrega chaves X.509 de um conjunto de armazéns de chaves persistentes para os seguintes chaveiros:

-

O chaveiro do sistema (

.builtin_trusted_keys) -

O chaveiro

.platform -

O sistema

.blacklistkeyring

Tabela 3.3. Fontes para chaveiros de sistema

| Fonte das chaves X.509 | O usuário pode adicionar chaves | UEFI Secure Boot state | Chaves carregadas durante a inicialização |

|---|---|---|---|

| Embutido no núcleo | Não | - |

|

| Bota Segura UEFI "db | Limitado | Não habilitado | Não |

| Habilitado |

| ||

|

Embutido no | Não | Não habilitado | Não |

| Habilitado |

| ||

| Lista de chaves do proprietário da máquina (MOK) | Sim | Não habilitado | Não |

| Habilitado |

|

.builtin_trusted_keys:

- um porta-chaves que é construído sobre o porta-chaves

- contém chaves públicas confiáveis

-

os privilégios do

rootsão necessários para visualizar as chaves

.platform:

- um porta-chaves que é construído sobre o porta-chaves

- contém chaves de fornecedores de plataformas de terceiros e chaves públicas personalizadas

-

os privilégios do

rootsão necessários para visualizar as chaves

.blacklist

- um chaveiro com chaves X.509 que foram revogadas

-

um módulo assinado por uma chave de

.blacklistfalhará a autenticação mesmo que sua chave pública esteja em.builtin_trusted_keys

UEFI Secure Boot db:

- um banco de dados de assinaturas

- armazena chaves (hashes) de aplicações UEFI, drivers UEFI, e bootloaders

- as chaves podem ser carregadas na máquina

UEFI Secure Boot dbx:

- um banco de dados de assinaturas revogado

- impede que as chaves sejam carregadas

-

as chaves revogadas deste banco de dados são adicionadas ao chaveiro

.blacklist

3.12.1.3. Geração de um par de chaves públicas e privadas

Você precisa gerar um par de chaves públicas e privadas X.509 para ter sucesso em seus esforços de usar os módulos do kernel em um sistema habilitado para Boot Seguro. Mais tarde, você usará a chave privada para assinar o módulo do kernel. Você também terá que adicionar a chave pública correspondente à Chave do Proprietário da Máquina (MOK) para o Secure Boot para validar o módulo assinado.

Alguns dos parâmetros para esta geração de pares chave são melhor especificados com um arquivo de configuração.

Procedimento

Criar um arquivo de configuração com parâmetros para a geração do par de chaves:

# cat << EOF > configuration_file.config [ req ] default_bits = 4096 distinguished_name = req_distinguished_name prompt = no string_mask = utf8only x509_extensions = myexts [ req_distinguished_name ] O = Organization CN = Organization signing key emailAddress = E-mail address [ myexts ] basicConstraints=critical,CA:FALSE keyUsage=digitalSignature subjectKeyIdentifier=hash authorityKeyIdentifier=keyid EOF

Criar um par de chaves públicas e privadas X.509, como mostrado no exemplo a seguir:

# openssl req -x509 -new -nodes -utf8 -sha256 -days 36500 \ -batch -config configuration_file.config -outform DER \ -out my_signing_key_pub.der \ -keyout my_signing_key.privA chave pública será escrita para o

my_signing_key_pub.dere a chave privada será escrita para o arquivomy_signing_key.privarquivo.ImportanteNo RHEL 8, as datas de validade do par chave são importantes. A chave não expira, mas o módulo do kernel deve ser assinado dentro do período de validade de sua chave de assinatura. Por exemplo, uma chave válida somente em 2019 pode ser usada para autenticar um módulo do kernel assinado em 2019 com essa chave. Entretanto, os usuários não podem usar essa chave para assinar um módulo de kernel em 2020.

Opcionalmente, você pode rever as datas de validade de suas chaves públicas, como no exemplo abaixo:

# openssl x509 -inform der -text -noout -in <my_signing_key_pub.der> Validity Not Before: Feb 14 16:34:37 2019 GMT Not After : Feb 11 16:34:37 2029 GMT- Inscreva sua chave pública em todos os sistemas onde você deseja autenticar e carregar seu módulo de kernel.

Aplique fortes medidas de segurança e políticas de acesso para proteger o conteúdo de sua chave privada. Nas mãos erradas, a chave poderia ser usada para comprometer qualquer sistema que seja autenticado pela chave pública correspondente.

Recursos adicionais

-

Para mais informações sobre a utilidade

openssl, consulte a página do manualopenssl(1). -

Para mais informações sobre o uso de

openssl, consulte o RHEL Security Guide - Para detalhes sobre o registro de chaves públicas em sistemas-alvo, veja Seção 3.12.3.2, “Acrescentar manualmente a chave pública à lista MOK”.

3.12.2. Exemplo de saída de chaveiros de sistema

Você pode exibir informações sobre as chaves nos chaveiros do sistema usando o utilitário keyctl.

A seguir, um exemplo abreviado de .builtin_trusted_keys, .platform e .blacklist keyrings de um sistema RHEL 8 onde o UEFI Secure Boot está habilitado.

# keyctl list %:.builtin_trusted_keys 6 keys in keyring: ...asymmetric: Red Hat Enterprise Linux Driver Update Program (key 3): bf57f3e87... ...asymmetric: Red Hat Secure Boot (CA key 1): 4016841644ce3a810408050766e8f8a29... ...asymmetric: Microsoft Corporation UEFI CA 2011: 13adbf4309bd82709c8cd54f316ed... ...asymmetric: Microsoft Windows Production PCA 2011: a92902398e16c49778cd90f99e... ...asymmetric: Red Hat Enterprise Linux kernel signing key: 4249689eefc77e95880b... ...asymmetric: Red Hat Enterprise Linux kpatch signing key: 4d38fd864ebe18c5f0b7... # keyctl list %:.platform 4 keys in keyring: ...asymmetric: VMware, Inc.: 4ad8da0472073... ...asymmetric: Red Hat Secure Boot CA 5: cc6fafe72... ...asymmetric: Microsoft Windows Production PCA 2011: a929f298e1... ...asymmetric: Microsoft Corporation UEFI CA 2011: 13adbf4e0bd82... # keyctl list %:.blacklist 4 keys in keyring: ...blacklist: bin:f5ff83a... ...blacklist: bin:0dfdbec... ...blacklist: bin:38f1d22... ...blacklist: bin:51f831f...

O chaveiro .builtin_trusted_keys acima mostra a adição de duas chaves do Boot Seguro da UEFI {\i1}"db{\i} assim como o Red Hat Secure Boot (CA key 1), que está embutido no carregador de inicialização shim.efi.

O exemplo a seguir mostra a saída do console do kernel. As mensagens identificam as chaves com uma fonte relacionada ao UEFI Secure Boot. Estas incluem a UEFI Secure Boot db, calço embutido e a lista MOK.

# dmesg | grep 'EFI: Loaded cert'

[5.160660] EFI: Loaded cert 'Microsoft Windows Production PCA 2011: a9290239...

[5.160674] EFI: Loaded cert 'Microsoft Corporation UEFI CA 2011: 13adbf4309b...

[5.165794] EFI: Loaded cert 'Red Hat Secure Boot (CA key 1): 4016841644ce3a8...Recursos adicionais

-

Para mais informações sobre

keyctlvejakeyctl(1)página do manual. -

Para mais informações sobre

dmesgvejadmesg(1)página do manual.

3.12.3. Inscrição de chave pública no sistema alvo

Quando a RHEL 8 inicializa em um sistema baseado em UEFI com boot seguro ativado, o kernel carrega no chaveiro do sistema (.builtin_trusted_keys) todas as chaves públicas que estão no banco de dados de chaves Secure Boot db. Ao mesmo tempo, o kernel exclui as chaves do banco de dados dbx de chaves revogadas. As seções abaixo descrevem diferentes maneiras de importar uma chave pública em um sistema alvo para que o chaveiro do sistema (.builtin_trusted_keys) seja capaz de usar a chave pública para autenticar um módulo do kernel.

3.12.3.1. Imagem do firmware de fábrica incluindo chave pública

Para facilitar a autenticação de seu módulo de kernel em seus sistemas, considere solicitar a seu fornecedor de sistemas que incorpore sua chave pública no banco de dados de chaves UEFI Secure Boot em sua imagem de firmware de fábrica.

3.12.3.2. Acrescentar manualmente a chave pública à lista MOK

O recurso de chave do proprietário da máquina (MOK) pode ser usado para expandir o banco de dados de chaves de Boot Seguro da UEFI. Quando a RHEL 8 inicializa um sistema UEFI com boot seguro ativado, as chaves da lista MOK também são adicionadas ao chaveiro do sistema (.builtin_trusted_keys), além das chaves do banco de dados de chaves. As chaves da lista MOK também são armazenadas de forma persistente e segura da mesma forma que as chaves do banco de dados do Secure Boot, mas estas são duas facilidades separadas. A instalação MOK é suportada por shim.efi, MokManager.efi, grubx64.efi, e pelo utilitário mokutil.

A inscrição de uma chave MOK requer a interação manual de um usuário no console do sistema UEFI em cada sistema alvo. Entretanto, a instalação MOK fornece um método conveniente para testar os pares de chaves recém-gerados e testar os módulos do kernel assinados com eles.

Procedimento

Solicite a adição de sua chave pública à lista MOK:

# mokutil --import my_signing_key_pub.derVocê será solicitado a entrar e confirmar uma senha para este pedido de inscrição MOK.

Reinicialize a máquina.

O pedido de inscrição da chave MOK pendente será notado por

shim.efie será lançadoMokManager.efipara permitir que você complete a inscrição a partir do console UEFI.Digite a senha que você associou anteriormente a esta solicitação e confirme a matrícula.

Sua chave pública é adicionada à lista MOK, que é persistente.

Assim que uma chave estiver na lista MOK, ela será automaticamente propagada para o chaveiro do sistema neste e nas botas subseqüentes quando a UEFI Secure Boot estiver habilitada.

3.12.4. Assinatura de módulos de kernel com a chave privada

Os usuários podem obter maiores benefícios de segurança em seus sistemas carregando módulos de kernel assinados se o mecanismo UEFI Secure Boot estiver habilitado. As seções seguintes descrevem como assinar módulos de kernel com a chave privada.

Pré-requisitos

- Você gerou um par de chaves públicas e privadas e conhece as datas de validade de suas chaves públicas. Para maiores detalhes, veja Seção 3.12.1.3, “Geração de um par de chaves públicas e privadas”.

- Você cadastrou sua chave pública no sistema alvo. Para maiores detalhes, veja Seção 3.12.3, “Inscrição de chave pública no sistema alvo”.

- Você tem um módulo de kernel em formato de imagem ELF disponível para assinatura.

Procedimento

Executar o utilitário

sign-filecom parâmetros como mostrado no exemplo abaixo:# /usr/src/kernels/$(uname -r)/scripts/sign-file \ sha256 \ my_signing_key.priv \ my_signing_key_pub.der \ my_module.kosign-filecomputa e anexa a assinatura diretamente à imagem ELF em seu arquivo de módulo do kernel. O utilitáriomodinfopode ser usado para exibir informações sobre a assinatura do módulo do kernel, caso ele esteja presente.NotaA assinatura anexa não está contida em uma seção de imagem ELF e não é uma parte formal da imagem ELF. Portanto, utilitários como

readelfnão serão capazes de exibir a assinatura em seu módulo do núcleo.Seu módulo de núcleo está agora pronto para ser carregado. Note que seu módulo de kernel assinado também é carregável em sistemas onde o UEFI Secure Boot está desabilitado ou em um sistema não UEFI. Isso significa que você não precisa fornecer tanto uma versão assinada como uma não assinada de seu módulo de kernel.

ImportanteNo RHEL 8, as datas de validade do par chave são importantes. A chave não expira, mas o módulo do kernel deve ser assinado dentro do período de validade de sua chave de assinatura. O utilitário

sign-filenão o advertirá sobre isso. Por exemplo, uma chave que só é válida em 2019 pode ser usada para autenticar um módulo do kernel assinado em 2019 com essa chave. Entretanto, os usuários não podem usar essa chave para assinar um módulo de kernel em 2020.

Recursos adicionais

-

Para obter detalhes sobre o uso do

modinfopara obter informações sobre os módulos do kernel, veja Seção 3.7, “Exibição de informações sobre os módulos do kernel”.

3.12.5. Carregamento de módulos de núcleo assinado

Uma vez que sua chave pública esteja inscrita no chaveiro do sistema (.builtin_trusted_keys) e na lista MOK, e após ter assinado o respectivo módulo kernel com sua chave privada, você pode finalmente carregar seu módulo kernel assinado com o comando modprobe, conforme descrito na seção seguinte.

Pré-requisitos

- Você gerou o par de chaves públicas e privadas. Para maiores detalhes, veja Seção 3.12.1.3, “Geração de um par de chaves públicas e privadas”.

- Você cadastrou a chave pública no chaveiro do sistema. Para maiores detalhes, veja Seção 3.12.3.2, “Acrescentar manualmente a chave pública à lista MOK”.

- Você assinou um módulo de kernel com a chave privada. Para maiores detalhes, veja Seção 3.12.4, “Assinatura de módulos de kernel com a chave privada”.

Procedimento

Verifique se suas chaves públicas estão no chaveiro do sistema:

# keyctl list %:.builtin_trusted_keysCopie o módulo do kernel para o diretório

/extra/do kernel que você deseja:# cp my_module.ko /lib/modules/$(uname -r)/extra/Atualizar a lista de dependência modular:

# depmod -aCarregar o módulo de kernel e verificar se foi carregado com sucesso:

# modprobe -v my_module # lsmod | grep my_module

Opcionalmente, para carregar o módulo na inicialização, adicione-o ao arquivo

/etc/modules-loaded.d/my_module.conf:# echo "my_module" > /etc/modules-load.d/my_module.conf

Recursos adicionais

- Para maiores informações sobre módulos de carregamento de kernel, veja as seções relevantes de Capítulo 3, Gerenciando módulos do núcleo.

Capítulo 4. Configuração dos parâmetros de linha de comando do kernel

Os parâmetros da linha de comando do kernel são uma forma de alterar o comportamento de certos aspectos do kernel do Red Hat Enterprise Linux no momento da inicialização. Como administrador de sistemas, você tem controle total sobre quais opções são definidas no momento da inicialização. Certos comportamentos do kernel só podem ser definidos no momento da inicialização, portanto, entender como fazer estas mudanças é uma habilidade chave de administração.

Optar por mudar o comportamento do sistema modificando os parâmetros da linha de comando do kernel pode ter efeitos negativos em seu sistema. Portanto, você deve testar as mudanças antes de implementá-las na produção. Para maiores orientações, entre em contato com o Suporte da Red Hat.

4.1. Entendendo os parâmetros da linha de comando do kernel

Os parâmetros da linha de comando do kernel são usados para a configuração do tempo de inicialização:

- O núcleo do Red Hat Enterprise Linux

- O disco RAM inicial

- As características do espaço do usuário

Os parâmetros de tempo de inicialização do kernel são freqüentemente usados para sobrescrever valores padrão e para definir configurações de hardware específicas.

Por padrão, os parâmetros de linha de comando do kernel para sistemas que utilizam o carregador de inicialização GRUB2 são definidos na variável kernelopts do arquivo /boot/grub2/grubenv para todas as entradas de inicialização do kernel.

Para IBM Z, os parâmetros da linha de comando do kernel são armazenados no arquivo de configuração de entrada de inicialização porque o carregador de inicialização zipl não suporta variáveis de ambiente. Portanto, a variável de ambiente kernelopts não pode ser usada.

Recursos adicionais

-

Para mais informações sobre quais parâmetros de linha de comando do kernel você pode modificar, veja

kernel-command-line(7),bootparam(7)edracut.cmdline(7)páginas de manual. -

Para mais informações sobre a variável

kernelopts, veja o artigo da base de conhecimento, Como instalar e inicializar kernels personalizados no Red Hat Enterprise Linux 8.

4.2. O que é

grubby é um utilitário para manipulação de arquivos de configuração específicos do bootloader.

Você pode usar grubby também para alterar a entrada padrão do boot, e para adicionar/remover argumentos de uma entrada do menu GRUB2.

Para obter mais detalhes, consulte a página do manual grubby(8).

4.3. O que são entradas de inicialização

Uma entrada de inicialização é uma coleção de opções que são armazenadas em um arquivo de configuração e vinculadas a uma versão particular do kernel. Na prática, você tem pelo menos tantas entradas de inicialização quanto seu sistema tem kernels instalados. O arquivo de configuração da entrada de inicialização está localizado no diretório /boot/loader/entries/ e pode se parecer com este:

6f9cc9cb7d7845d49698c9537337cedc-4.18.0-5.el8.x86_64.conf

O nome do arquivo acima consiste de uma identificação de máquina armazenada no arquivo /etc/machine-id, e uma versão do kernel.

O arquivo de configuração de entrada de inicialização contém informações sobre a versão do kernel, a imagem ramdisk inicial e a variável de ambiente kernelopts, que contém os parâmetros da linha de comando do kernel. O conteúdo de uma configuração de entrada de inicialização pode ser visto abaixo:

title Red Hat Enterprise Linux (4.18.0-74.el8.x86_64) 8.0 (Ootpa) version 4.18.0-74.el8.x86_64 linux /vmlinuz-4.18.0-74.el8.x86_64 initrd /initramfs-4.18.0-74.el8.x86_64.img $tuned_initrd options $kernelopts $tuned_params id rhel-20190227183418-4.18.0-74.el8.x86_64 grub_users $grub_users grub_arg --unrestricted grub_class kernel

A variável de ambiente kernelopts está definida no arquivo /boot/grub2/grubenv.

Recursos adicionais

Para mais informações sobre a variável kernelopts, veja o artigo da base de conhecimento Como instalar e inicializar kernels personalizados no Red Hat Enterprise Linux 8.

4.4. Ajuste dos parâmetros da linha de comando do kernel

Para ajustar o comportamento de seu sistema desde os estágios iniciais do processo de inicialização, você precisa definir certos parâmetros de linha de comando do kernel.

Esta seção explica como alterar os parâmetros da linha de comando do kernel em várias arquiteturas de CPU.

4.4.1. Mudança dos parâmetros de linha de comando do kernel para todas as entradas de inicialização

Este procedimento descreve como alterar os parâmetros de linha de comando do kernel para todas as entradas de inicialização em seu sistema.

Pré-requisitos

-

Verifique se as utilidades

grubbyeziplestão instaladas em seu sistema.

Procedimento

Para adicionar um parâmetro:

# grubby --update-kernel=ALL --args="<NEW_PARAMETER>"Para sistemas que utilizam o bootloader GRUB2, o comando atualiza o arquivo

/boot/grub2/grubenvadicionando um novo parâmetro do kernel à variávelkerneloptsnesse arquivo.No IBM Z que usa o bootloader zIPL, o comando adiciona um novo parâmetro de kernel a cada

/boot/loader/entries/<ENTRY>.confarquivo.-

No IBM Z, execute o comando

ziplsem opções de atualização do menu de inicialização.

-

No IBM Z, execute o comando

Para remover um parâmetro:

# grubby --update-kernel=ALL --remove-args="<PARAMETER_TO_REMOVE>"-

No IBM Z, execute o comando

ziplsem opções de atualização do menu de inicialização.

-

No IBM Z, execute o comando

Recursos adicionais

- Para mais informações sobre os parâmetros da linha de comando do kernel, veja Seção 4.1, “Entendendo os parâmetros da linha de comando do kernel”.

-

Para informações sobre a utilidade

grubby, consulte a página do manualgrubby(8). -

Para mais exemplos sobre como usar

grubby, veja o grubby tool. -

Para informações sobre a utilidade

zipl, consulte a página do manualzipl(8).

4.4.2. Alteração dos parâmetros da linha de comando do kernel para uma única entrada de inicialização

Este procedimento descreve como alterar os parâmetros da linha de comando do kernel para uma única entrada de inicialização em seu sistema.

Pré-requisitos

-

Verifique se as utilidades

grubbyeziplestão instaladas em seu sistema.

Procedimento

Para adicionar um parâmetro:

# grubby --update-kernel=/boot/vmlinuz-$(uname -r) --args="<NEW_PARAMETER>"-

No IBM Z, execute o comando

ziplsem opções de atualização do menu de inicialização.

-

No IBM Z, execute o comando

Para remover um parâmetro, use o seguinte:

# grubby --update-kernel=/boot/vmlinuz-$(uname -r) --remove-args="<PARAMETER_TO_REMOVE>"-

No IBM Z, execute o comando

ziplsem opções de atualização do menu de inicialização.

-

No IBM Z, execute o comando

Nos sistemas que utilizam o arquivo grub.cfg, existe, por padrão, o parâmetro options para cada entrada de inicialização do kernel, que é definido para a variável kernelopts. Esta variável é definida no arquivo de configuração /boot/grub2/grubenv.

Nos sistemas GRUB2:

-

Se os parâmetros da linha de comando do kernel forem modificados para todas as entradas de inicialização, o utilitário

grubbyatualiza a variávelkerneloptsno arquivo/boot/grub2/grubenv. -

Se os parâmetros da linha de comando do kernel forem modificados para uma única entrada de inicialização, a variável

kerneloptsé expandida, os parâmetros do kernel são modificados e o valor resultante é armazenado no arquivo/boot/loader/entries/<RELEVANT_KERNEL_BOOT_ENTRY.conf>da respectiva entrada de inicialização.

Em sistemas zIPL:

-

grubbymodifica e armazena os parâmetros da linha de comando do kernel de uma entrada de inicialização individual do kernel no/boot/loader/entries/<ENTRY>.confarquivo.

Recursos adicionais

- Para mais informações sobre os parâmetros da linha de comando do kernel, veja Seção 4.1, “Entendendo os parâmetros da linha de comando do kernel”.

-

Para informações sobre a utilidade

grubby, consulte a página do manualgrubby(8). -

Para mais exemplos sobre como usar

grubby, veja o grubby tool. -

Para informações sobre a utilidade

zipl, consulte a página do manualzipl(8).

Capítulo 5. Configuração dos parâmetros do kernel em tempo de execução

Como administrador de sistemas, você pode modificar muitas facetas do comportamento do kernel do Red Hat Enterprise Linux em tempo de execução. Esta seção descreve como configurar os parâmetros do kernel em tempo de execução, usando o comando sysctl e modificando os arquivos de configuração nos diretórios /etc/sysctl.d/ e /proc/sys/.

5.1. O que são parâmetros do kernel

Os parâmetros do kernel são valores ajustáveis que você pode ajustar enquanto o sistema está em funcionamento. Não há necessidade de reiniciar ou recompilar o kernel para que as mudanças tenham efeito.

É possível abordar os parâmetros do kernel através:

-

O comando

sysctl -

O sistema de arquivo virtual montado no diretório

/proc/sys/ -

Os arquivos de configuração no diretório

/etc/sysctl.d/

Os túneis são divididos em classes pelo subsistema de kernel. O Red Hat Enterprise Linux tem as seguintes classes sintonizáveis:

Tabela 5.1. Tabela de classes de sysctl

| Classe sintonizável | Subsistema |

|---|---|

| abi | Domínios e personalidades de execução |

| crypto | Interfaces criptográficas |

| debug | Interfaces de depuração do kernel |

| dev | Informações específicas sobre os dispositivos |

| fs | Sintonizáveis globais e específicos do sistema de arquivo |

| kernel | Sintonizadores globais de kernel |

| net | Sintonizadores de rede |

| sunrpc | Chamada de Procedimento Remoto do Sol (NFS) |

| usuário | Limites do espaço de nomes de usuários |

| vm | Afinação e gerenciamento de memória, buffers e cache |

Recursos adicionais

-

Para mais informações sobre

sysctl, consulte as páginas do manualsysctl(8). -

Para mais informações sobre

/etc/sysctl.d/veja,sysctl.d(5)páginas do manual.

5.2. Ajuste dos parâmetros do núcleo em tempo de execução

A configuração dos parâmetros do kernel em um sistema de produção requer um planejamento cuidadoso. Alterações não planejadas podem tornar o kernel instável, exigindo uma reinicialização do sistema. Verifique se você está usando opções válidas antes de alterar quaisquer valores do kernel.

5.2.1. Configuração temporária dos parâmetros do kernel com sysctl

O procedimento a seguir descreve como usar o comando sysctl para definir temporariamente os parâmetros do kernel em tempo de execução. O comando também é útil para listar e filtrar os sintonizadores.

Pré-requisitos

- Introdução aos parâmetros do Kernel

- Permissões de raiz

Procedimento

Para listar todos os parâmetros e seus valores, use o seguinte:

# sysctl -aNotaO comando

# sysctl -aexibe os parâmetros do kernel, que podem ser ajustados em tempo de execução e em tempo de inicialização.Para configurar um parâmetro temporariamente, use o comando como no exemplo a seguir:

# sysctl <TUNABLE_CLASS>.<PARAMETER>=<TARGET_VALUE>O comando de amostra acima altera o valor do parâmetro enquanto o sistema está em funcionamento. As mudanças entram em vigor imediatamente, sem necessidade de reiniciar.

NotaAs mudanças retornam ao padrão após o reinício de seu sistema.

Recursos adicionais

-

Para mais informações sobre

sysctl, consulte a página do manualsysctl(8). -

Para modificar permanentemente os parâmetros do kernel, use o comando

sysctlpara escrever os valores no arquivo/etc/sysctl.confou faça alterações manuais nos arquivos de configuração no diretório/etc/sysctl.d/.

5.2.2. Configuração permanente dos parâmetros do kernel com sysctl

O procedimento a seguir descreve como usar o comando sysctl para definir permanentemente os parâmetros do kernel.

Pré-requisitos

- Introdução aos parâmetros do Kernel

- Permissões de raiz

Procedimento

Para listar todos os parâmetros, use o seguinte:

# sysctl -aO comando exibe todos os parâmetros do kernel que podem ser configurados em tempo de execução.

Para configurar um parâmetro permanentemente:

# sysctl -w <TUNABLE_CLASS>.<PARAMETER>=<TARGET_VALUE> >> /etc/sysctl.confO comando de amostra altera o valor sintonizável e o grava no arquivo

/etc/sysctl.conf, que sobrepõe os valores padrão dos parâmetros do kernel. As mudanças entram em vigor imediata e persistentemente, sem necessidade de reinício.

Para modificar permanentemente os parâmetros do kernel, você também pode fazer alterações manuais nos arquivos de configuração no diretório /etc/sysctl.d/.

Recursos adicionais

-

Para mais informações sobre

sysctl, consulte as páginas do manualsysctl(8)esysctl.conf(5). -

Para maiores informações sobre o uso dos arquivos de configuração no diretório

/etc/sysctl.d/para fazer mudanças permanentes nos parâmetros do kernel, veja Usando arquivos de configuração em /etc/sysctl.d/ para ajustar os parâmetros do kernel.

5.2.3. Usando arquivos de configuração em /etc/sysctl.d/ para ajustar os parâmetros do kernel

O procedimento seguinte descreve como modificar manualmente os arquivos de configuração no diretório /etc/sysctl.d/ para definir permanentemente os parâmetros do kernel.

Pré-requisitos

- Introdução aos parâmetros do Kernel

- Permissões de raiz

Procedimento

Criar um novo arquivo de configuração em

/etc/sysctl.d/:# vim /etc/sysctl.d/<some_file.conf>Incluir parâmetros de kernel, um por linha, como se segue:

<TUNABLE_CLASS>.<PARAMETER>=<TARGET_VALUE><TUNABLE_CLASS>.<PARAMETER>=<TARGET_VALUE>- Salvar o arquivo de configuração.

Reinicie a máquina para que as mudanças entrem em vigor.

Alternativamente, para aplicar as mudanças sem reiniciar, executar:

# sysctl -p /etc/sysctl.d/<some_file.conf>O comando permite a leitura dos valores do arquivo de configuração, que você criou anteriormente.

Recursos adicionais

-

Para mais informações sobre

sysctl, consulte a página do manualsysctl(8). -

Para mais informações sobre

/etc/sysctl.d/, consulte a página do manualsysctl.d(5).

5.2.4. Configuração temporária dos parâmetros do kernel através de /proc/sys/

O procedimento a seguir descreve como definir temporariamente os parâmetros do kernel através dos arquivos no diretório /proc/sys/ do sistema de arquivos virtual.

Pré-requisitos

- Introdução aos parâmetros do Kernel

- Permissões de raiz

Procedimento

Identificar um parâmetro do kernel que você deseja configurar:

# ls -l /proc/sys/<TUNABLE_CLASS>/Os arquivos graváveis retornados pelo comando podem ser usados para configurar o kernel. Os arquivos com permissões somente de leitura fornecem feedback sobre as configurações atuais.

Atribuir um valor-alvo ao parâmetro kernel:

# echo <TARGET_VALUE> > /proc/sys/<TUNABLE_CLASS>/<PARAMETER>O comando faz mudanças de configuração que desaparecerão assim que o sistema for reiniciado.

Opcionalmente, verifique o valor do parâmetro do kernel recém ajustado:

# cat /proc/sys/<TUNABLE_CLASS>/<PARAMETER>

Recursos adicionais

-

Para modificar permanentemente os parâmetros do kernel, use o comando

sysctlou faça alterações manuais nos arquivos de configuração no diretório/etc/sysctl.d/.

5.3. Manter os parâmetros de pânico do núcleo desabilitados em ambientes virtualizados

Ao configurar um ambiente virtualizado no Red Hat Enterprise Linux 8 (RHEL 8), você não deve ativar os parâmetros do kernel softlockup_panic e nmi_watchdog, pois o ambiente virtualizado pode desencadear um bloqueio suave espúrio que não deve exigir um pânico do sistema.

As seções seguintes explicam as razões por trás deste conselho, resumindo-as:

- O que causa um bloqueio suave.

- Descrevendo os parâmetros de kernel que controlam o comportamento de um sistema em um bloqueio suave.

- Explicando como os bloqueios suaves podem ser acionados em um ambiente virtualizado.

5.3.1. O que é um bloqueio suave?

Um bloqueio suave é uma situação geralmente causada por um bug, quando uma tarefa é executada no espaço do kernel de uma CPU sem reprogramação. A tarefa também não permite que nenhuma outra tarefa seja executada naquela CPU em particular. Como resultado, um aviso é exibido a um usuário através do console do sistema. Este problema também é chamado de disparo de travamento suave.

Recursos adicionais

- Por uma razão técnica por trás de um bloqueio suave, exemplos de mensagens de registro, e outros detalhes, veja o seguinte Knowledge Article.

5.3.2. Parâmetros que controlam o pânico no núcleo

Os seguintes parâmetros do núcleo podem ser definidos para controlar o comportamento de um sistema quando um bloqueio suave é detectado.

- softlockup_panic

Controla se o núcleo entra ou não em pânico quando um bloqueio suave é detectado.

Tipo Valor Efeito Inteiro

0

o kernel não entra em pânico com fechadura macia

Inteiro

1

pânico no miolo em um bloqueio macio

Por padrão, na RHEL8 este valor é 0.

A fim de entrar em pânico, o sistema precisa detectar primeiro um bloqueio duro. A detecção é controlada pelo parâmetro

nmi_watchdog.- nmi_watchdog

Controla se os mecanismos de detecção de lockup (

watchdogs) estão ativos ou não. Este parâmetro é do tipo inteiro.Valor Efeito 0

desabilita o detector de bloqueio

1

permite o bloqueio do detector

O detector de travamento rígido monitora cada CPU quanto à sua capacidade de responder a interrupções.

- watchdog_thresh

Controla a freqüência do cão de guarda

hrtimer, eventos NMI, e limiares de bloqueio suave/duro.Limite por defeito Limiar de bloqueio suave 10 segundos

2 *

watchdog_threshA definição deste parâmetro para zero desabilita totalmente a detecção de bloqueio.

Recursos adicionais

-

Para maiores informações sobre

nmi_watchdogesoftlockup_panic, veja o Softlockup detector and hardlockup detector documento. -

Para mais detalhes sobre

watchdog_thresh, veja o Kernel sysctl documento.

5.3.3. Trancamentos suaves e espúrios em ambientes virtualizados

O travamento suave acionado em hosts físicos, como descrito em Seção 5.3.1, “O que é um bloqueio suave?”, geralmente representa um kernel ou bug de hardware. O mesmo fenômeno que ocorre em sistemas operacionais convidados em ambientes virtualizados pode representar um falso aviso.

A carga de trabalho pesada sobre um host ou a alta contenção sobre algum recurso específico, como a memória, geralmente causa um falso disparo de um cadeado macio. Isto porque o anfitrião pode programar a CPU do convidado por um período superior a 20 segundos. Então, quando a CPU do convidado é novamente programada para rodar no host, ela experimenta um time jump que aciona os devidos temporizadores. Os temporizadores incluem também o watchdog hrtimer, que pode conseqüentemente reportar um travamento suave na CPU do convidado.

Como um bloqueio suave em um ambiente virtualizado pode ser espúrio, você não deve ativar os parâmetros do kernel que causariam pânico no sistema quando um bloqueio suave for reportado em uma CPU de convidado.

Para entender os trancamentos suaves nos hóspedes, é essencial saber que o anfitrião agenda o hóspede como uma tarefa, e o hóspede então agenda suas próprias tarefas.

Recursos adicionais

- Para definição de bloqueio suave e aspectos técnicos por trás de seu funcionamento, ver Seção 5.3.1, “O que é um bloqueio suave?”.

- Para aprender sobre os componentes dos ambientes virtualizados RHEL 8 e sua interação, veja RHEL 8 virtual machine components and their interaction.

5.4. Ajuste dos parâmetros do kernel para servidores de banco de dados

Existem diferentes conjuntos de parâmetros de kernel que podem afetar o desempenho de aplicações específicas de bancos de dados. As seções seguintes explicam quais parâmetros do kernel devem ser configurados para garantir o funcionamento eficiente dos servidores de banco de dados e das bases de dados.

5.4.1. Introdução aos servidores de banco de dados

Um servidor de banco de dados é um dispositivo de hardware que tem uma certa quantidade de memória principal, e um aplicativo de banco de dados (DB) instalado. Esta aplicação DB fornece serviços como um meio de escrever os dados em cache da memória principal, que normalmente é pequena e cara, para arquivos DB (banco de dados). Estes serviços são fornecidos a vários clientes em uma rede. Pode haver tantos servidores de banco de dados quanto a memória principal de uma máquina e o armazenamento permitem.

O Red Hat Enterprise Linux 8 fornece as seguintes aplicações de banco de dados:

- MariaDB 10.3

- MySQL 8.0

- PostgreSQL 10

- PostgreSQL 9.6

- PostgreSQL 12 - disponível desde RHEL 8.1.1

5.4.2. Parâmetros que afetam o desempenho das aplicações de banco de dados

Os seguintes parâmetros do kernel afetam o desempenho das aplicações de banco de dados.

- fs.aio-max-nr

Define o número máximo de operações assíncronas de E/S que o sistema pode realizar no servidor.

NotaO aumento do parâmetro

fs.aio-max-nrnão produz mudanças adicionais além do aumento do limite do aio.- fs.file-max

Define o número máximo de manipulações de arquivos (nomes de arquivos temporários ou IDs atribuídos a arquivos abertos) que o sistema suporta em qualquer instância.

O kernel aloca dinamicamente as alças dos arquivos sempre que uma alça de arquivo é solicitada por uma aplicação. O kernel, no entanto, não libera esses manipuladores de arquivos quando eles são liberados pela aplicação. Em vez disso, o kernel recicla estes manipuladores de arquivos. Isto significa que, com o tempo, o número total de file handles alocados aumentará mesmo que o número de file handles usados atualmente possa ser baixo.

- kernel.shmall

-

Define o número total de páginas de memória compartilhada que podem ser usadas em todo o sistema. Para utilizar toda a memória principal, o valor do parâmetro

kernel.shmalldeve ser ≤ tamanho total da memória principal. - kernel.shmmax

- Define o tamanho máximo em bytes de um único segmento de memória compartilhada que um processo Linux pode alocar em seu espaço de endereçamento virtual.

- kernel.shmmni

- Define o número máximo de segmentos de memória compartilhada que o servidor de banco de dados é capaz de lidar.

- net.ipv4.ip_local_port_range

- Define a faixa de porta que o sistema pode usar para programas que desejam se conectar a um servidor de banco de dados sem um número de porta específico.

- net.core.rmem_default

- Define a memória padrão do soquete de recepção através do Protocolo de Controle de Transmissão (TCP).

- net.core.rmem_max

- Define a memória máxima do soquete de recepção através do Protocolo de Controle de Transmissão (TCP).

- net.core.wmem_default

- Define a memória padrão do soquete de envio através do Protocolo de Controle de Transmissão (TCP).

- net.core.wmem_max

- Define a memória máxima do soquete de envio através do Protocolo de Controle de Transmissão (TCP).

- vm.dirty_bytes / vm.dirty_ratio

-

Define um limite em bytes / em porcentagem de memória suja na qual um processo gerando dados sujos é iniciado na função

write().

Either vm.dirty_bytes or vm.dirty_ratio pode ser especificado de cada vez.

- vm.dirty_background_bytes / vm.dirty_background_ratio

- Define um limite em bytes / em porcentagem de memória suja em que o kernel tenta escrever ativamente dados sujos no disco rígido.

Either vm.dirty_background_bytes or vm.dirty_background_ratio pode ser especificado de cada vez.

- vm.dirty_writeback_centisecs

Define um intervalo de tempo entre os despertares periódicos dos fios do núcleo responsáveis pela escrita de dados sujos no disco rígido.

Estes parâmetros de kernel medem em 100º de um segundo.

- vm.dirty_expire_centisecs

Define o tempo após o qual os dados sujos são suficientemente velhos para serem escritos em disco rígido.

Estes parâmetros de kernel medem em 100º de um segundo.

Recursos adicionais

- Para obter explicações sobre os dados sujos, como funcionam e quais os parâmetros do núcleo que se relacionam com eles, veja o Dirty pagecache writeback and vm.dirty parameters documento.

Capítulo 6. Começando com o registro do kernel

Arquivos de log são arquivos que contêm mensagens sobre o sistema, incluindo o kernel, serviços e aplicações em execução no mesmo. O sistema de registro no Red Hat Enterprise Linux é baseado no protocolo syslog embutido. Vários utilitários usam este sistema para registrar eventos e organizá-los em arquivos de log. Estes arquivos são úteis ao auditar o sistema operacional ou solucionar problemas.

6.1. O que é o tampão de anel de amêndoa

Durante o processo de inicialização, o console fornece muitas informações importantes sobre a fase inicial da inicialização do sistema. Para evitar a perda das mensagens iniciais, o kernel utiliza o que é chamado de buffer de anel. Este buffer armazena todas as mensagens, inclusive as mensagens de inicialização, geradas pela função printk() dentro do código do kernel. As mensagens do buffer de anéis do kernel são então lidas e armazenadas em arquivos de log em armazenamento permanente, por exemplo, pelo serviço syslog.

O buffer mencionado acima é uma estrutura de dados cíclica que tem um tamanho fixo, e é codificada no núcleo. Os usuários podem exibir os dados armazenados no buffer de anel do kernel através do comando dmesg ou do arquivo /var/log/boot.log. Quando o buffer de anéis está cheio, os novos dados sobrescrevem os antigos.

Recursos adicionais

-

Para mais informações sobre

syslog, consulte a página do manualsyslog(2). -

Para mais detalhes sobre como examinar ou controlar as mensagens de registro de inicialização com

dmesg, consulte a página do manualdmesg(1).

6.2. Papel da impressão em nível de log e kernel logging

Cada mensagem que o kernel reporta tem um nível de log associado a ela que define a importância da mensagem. O buffer de anel do kernel, conforme descrito em Seção 6.1, “O que é o tampão de anel de amêndoa”, coleta mensagens do kernel de todos os níveis de log. É o parâmetro kernel.printk que define quais mensagens do buffer são impressas para o console.

Os valores em nível de log se decompõem nesta ordem:

- 0 - Emergência do núcleo. O sistema é inutilizável.

- 1 - Alerta de kernel. As ações devem ser tomadas imediatamente.

- 2 - A condição do miolo é considerada crítica.

- 3 - Condição de erro geral do kernel.

- 4 - Condição geral de alerta do núcleo.

- 5 - Aviso de uma condição normal, mas significativa.

- 6 - Mensagem informativa do kernel.

- 7 - Mensagens de nível de depuração do kernel.

Por padrão, kernel.printk no RHEL 8 contém os quatro valores a seguir:

# sysctl kernel.printk

kernel.printk = 7 4 1 7Os quatro valores definem o seguinte:

- valor. O nível de log do console, define a prioridade mais baixa de mensagens impressas no console.

- valor. Nível de registro padrão para mensagens sem um nível de registro explícito anexado a elas.

- valor. Define a configuração mais baixa possível do nível de log para o nível de log do console.

valor. Define o valor padrão para o nível de log do console no momento da inicialização.

Cada um desses valores acima define uma regra diferente para o tratamento de mensagens de erro.

O valor padrão 7 4 1 7 printk permite uma melhor depuração da atividade do kernel. Entretanto, quando acoplado a um console serial, esta configuração printk é capaz de causar explosões intensas de E/S que podem levar a um sistema RHEL a ficar temporariamente sem resposta. Para evitar estas situações, a configuração de um valor printk de 4 4 1 7 normalmente funciona, mas às custas de perder a informação extra de depuração.

Observe também que certos parâmetros de linha de comando do kernel, tais como quiet ou debug, alteram os valores padrão kernel.printk.

Recursos adicionais

-

Para mais informações sobre

kernel.printke níveis de log, consulte a página do manualsyslog(2).

Capítulo 7. Instalando e configurando o kdump

7.1. O que é kdump

kdump é um serviço que fornece um mecanismo de despejo de emergência. O serviço permite salvar o conteúdo da memória do sistema para análise posterior. kdump usa a chamada do sistema kexec para inicializar no segundo kernel (a capture kernel) sem reinicializar; e então captura o conteúdo da memória do kernel travado (a crash dump ou a vmcore) e o salva. O segundo kernel reside em uma parte reservada da memória do sistema.

Um despejo de kernel pode ser a única informação disponível no caso de uma falha no sistema (um bug crítico). Portanto, garantir que kdump esteja operacional é importante em ambientes de missão crítica. A Red Hat recomenda que os administradores de sistema atualizem e testem regularmente kexec-tools em seu ciclo normal de atualização do kernel. Isto é especialmente importante quando novos recursos do kernel são implementados.

7.2. Instalando o kdump

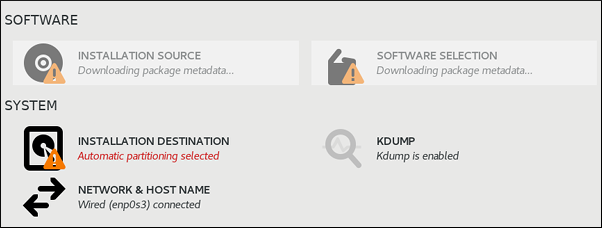

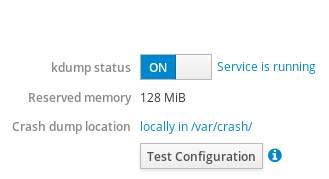

Em muitos casos, o serviço kdump é instalado e ativado por default nas novas instalações do Red Hat Enterprise Linux. O Anaconda o instalador fornece uma tela para a configuração kdump ao realizar uma instalação interativa usando a interface gráfica ou de texto. A tela do instalador tem o título Kdump e está disponível na tela principal Installation Summary, e permite apenas uma configuração limitada - você só pode selecionar se kdump está habilitado e quanta memória está reservada.

Algumas opções de instalação, tais como instalações Kickstart personalizadas, em alguns casos não instalam ou ativam kdump por padrão. Se este for o caso em seu sistema, siga o procedimento abaixo para instalar kdump.

Pré-requisitos

- Uma assinatura ativa do Red Hat Enterprise Linux

- Um repositório contendo o kexec-tools pacote para a arquitetura da CPU de seu sistema

-

Cumpridos os requisitos

kdump

Procedimento

Execute o seguinte comando para verificar se

kdumpestá instalado em seu sistema:$ rpm -q kexec-toolsSaída se o pacote for instalado:

kexec-tools-2.0.17-11.el8.x86_64Saída se o pacote não estiver instalado:

package kexec-tools is not installedInstale

kdumpe outros pacotes necessários por:# yum install kexec-tools

Começando com o Red Hat Enterprise Linux 7.4 (kernel-3.10.0-693.el7), o driver Intel IOMMU é suportado com kdump. Para versões anteriores, Red Hat Enterprise Linux 7.3 (kernel-3.10.0-514[.XYZ].el7) e anteriores, é aconselhável que o suporte Intel IOMMU seja desativado, caso contrário o kdump kernel provavelmente não responderá.

Recursos adicionais

-

Informações sobre os requisitos de memória para

kdumpestão disponíveis em Seção 7.5.1, “Requisitos de memória para kdump”.

7.3. Configuração do kdump na linha de comando

7.3.1. Configuração do uso da memória kdump

A memória para kdump é reservada durante a inicialização do sistema. O tamanho da memória é configurado no arquivo de configuração do Grand Unified Bootloader (GRUB) 2 do sistema. O tamanho da memória depende do valor crashkernel= especificado no arquivo de configuração e do tamanho da memória física do sistema.

A opção crashkernel= pode ser definida de várias maneiras. Você pode especificar o valor crashkernel= ou configurar a opção auto. A opção crashkernel=auto boot, reserva a memória automaticamente, dependendo da quantidade total de memória física do sistema. Quando configurado, o kernel reservará automaticamente uma quantidade apropriada de memória necessária para o kernel kdump. Isto ajuda a evitar a ocorrência de erros fora da memória (OOM).

A alocação automática de memória para kdump varia de acordo com a arquitetura de hardware do sistema e o tamanho da memória disponível.

Por exemplo, no AMD64 e Intel 64, o parâmetro crashkernel=auto só funciona quando a memória disponível é superior a 1GB e a arquitetura ARM de 64 bits e os sistemas IBM Power Systems têm memória disponível superior a 2GB.

Se o sistema tiver menos do que o limite mínimo de memória para alocação automática, você pode configurar manualmente a quantidade de memória reservada.

Pré-requisitos

-

Cumpridos os requisitos

kdump

Procedimento

-

Edite o arquivo

/etc/default/grubusando as permissões de raiz. Defina a opção

crashkernel=para o valor requerido.Por exemplo, para reservar 128 MB de memória, use o seguinte:

crashkernel=128M