Red Hat Training

A Red Hat training course is available for RHEL 8

Configuração e gerenciamento de clusters de alta disponibilidade

Configuração e gerenciamento do Red Hat High Availability Add-On

Resumo

Tornando o código aberto mais inclusivo

A Red Hat tem o compromisso de substituir a linguagem problemática em nosso código, documentação e propriedades da web. Estamos começando com estes quatro termos: master, slave, blacklist e whitelist. Por causa da enormidade deste esforço, estas mudanças serão implementadas gradualmente ao longo de vários lançamentos futuros. Para mais detalhes, veja a mensagem de nosso CTO Chris Wright.

Fornecendo feedback sobre a documentação da Red Hat

Agradecemos sua contribuição em nossa documentação. Por favor, diga-nos como podemos melhorá-la. Para fazer isso:

Para comentários simples sobre passagens específicas:

- Certifique-se de que você está visualizando a documentação no formato Multi-page HTML. Além disso, certifique-se de ver o botão Feedback no canto superior direito do documento.

- Use o cursor do mouse para destacar a parte do texto que você deseja comentar.

- Clique no pop-up Add Feedback que aparece abaixo do texto destacado.

- Siga as instruções apresentadas.

Para enviar comentários mais complexos, crie um bilhete Bugzilla:

- Ir para o site da Bugzilla.

- Como Componente, use Documentation.

- Preencha o campo Description com sua sugestão de melhoria. Inclua um link para a(s) parte(s) relevante(s) da documentação.

- Clique em Submit Bug.

Capítulo 1. Visão geral do Add-On de Alta Disponibilidade

O Add-On de Alta Disponibilidade é um sistema agrupado que proporciona confiabilidade, escalabilidade e disponibilidade para serviços críticos de produção.

Um cluster são dois ou mais computadores (chamados nodes ou members) que trabalham juntos para realizar uma tarefa. Os clusters podem ser usados para fornecer serviços ou recursos altamente disponíveis. A redundância de múltiplas máquinas é usada para proteger contra falhas de muitos tipos.

Os clusters de alta disponibilidade oferecem serviços altamente disponíveis, eliminando pontos únicos de falha e falhando nos serviços de um nó de cluster para outro caso um nó se torne inoperante. Tipicamente, os serviços em um cluster de alta disponibilidade lêem e escrevem dados (por meio de sistemas de arquivos montados de leitura-escrita). Portanto, um cluster de alta disponibilidade deve manter a integridade dos dados quando um nó de cluster assume o controle de um serviço de outro nó de cluster. As falhas de um nó em um cluster de alta disponibilidade não são visíveis de clientes fora do cluster. (Os clusters de alta disponibilidade são às vezes chamados de clusters de failover.) O Add-On de Alta Disponibilidade fornece clustering de alta disponibilidade através de seu componente de gerenciamento de serviços de alta disponibilidade, Pacemaker.

1.1. Componentes adicionais de alta disponibilidade

O Add-On de Alta Disponibilidade consiste nos seguintes componentes principais:

- Infra-estrutura do cluster

- Gestão de serviços de alta disponibilidade

- Ferramentas de administração de clusters

Você pode complementar o Add-On de Alta Disponibilidade com os seguintes componentes:

- Red Hat GFS2 (Global File System 2)

-

LVM Locking Daemon (

lvmlockd) - Balanceador de carga

1.2. Visão geral do marcapasso

Pacemaker é um gerente de recursos de cluster. Ele alcança a máxima disponibilidade para seus serviços e recursos de cluster fazendo uso das capacidades de mensagens e membros da infra-estrutura de cluster para dissuadir e recuperar de falhas nos nós e nos recursos.

1.2.1. Componentes da arquitetura do marcapasso

Um cluster configurado com Pacemaker é composto de daemons componentes separados que monitoram os membros do cluster, scripts que gerenciam os serviços, e subsistemas de gerenciamento de recursos que monitoram os recursos díspares.

Os seguintes componentes formam a arquitetura do Pacemaker:

- Base de Informações do Cluster (CIB)

- O daemon de informação do Pacemaker, que usa XML internamente para distribuir e sincronizar a configuração atual e informações de status do Coordenador Designado (DC)

- Daemon de Gerenciamento de Recursos de Cluster (CRMd)

As ações de recursos de agrupamento de marcapassos são encaminhadas através deste daemon. Os recursos gerenciados pelo CRMd podem ser consultados pelos sistemas do cliente, movidos, instanciados e alterados quando necessário.

Cada nó de cluster também inclui um daemon (LRMd) gerente de recursos local que atua como uma interface entre CRMd e recursos. O LRMd passa os comandos do CRMd para os agentes, tais como iniciar e parar e retransmitir informações de status.

- Atire no Outro Nó da Cabeça (STONITH)

- STONITH é a implementação da esgrima do Pacemaker. Ela atua como um recurso de cluster no Pacemaker que processa pedidos de cercas, fechando forçosamente os nós e removendo-os do cluster para garantir a integridade dos dados. STONITH é configurado na CIB e pode ser monitorado como um recurso normal de cluster. Para uma visão geral das cercas, veja Seção 1.3, “Visão geral da vedação”.

- corosync

corosyncé o componente - e um daemon com o mesmo nome - que atende às principais necessidades de adesão e de comunicação dos membros para os clusters de alta disponibilidade. Ele é necessário para que o Add-On de Alta Disponibilidade funcione.Além dessas funções de afiliação e de envio de mensagens,

corosynctambém:- Gerencia as regras de quorum e determinação.

- Fornece recursos de mensagens para aplicações que coordenam ou operam em múltiplos membros do cluster e, portanto, devem comunicar informações estatais ou outras informações entre as instâncias.

-

Utiliza a biblioteca

kronosnetcomo seu transporte de rede para fornecer múltiplos links redundantes e failover automático.

1.2.2. Ferramentas de configuração e gerenciamento

O Add-On de Alta Disponibilidade apresenta duas ferramentas de configuração para implantação, monitoramento e gerenciamento de clusters.

pcsA interface de linha de comando

pcscontrola e configura o Pacemaker e o daemon de batimento cardíacocorosync. Um programa baseado em linha de comando,pcspode realizar as seguintes tarefas de gerenciamento de clusters:- Criar e configurar um cluster Pacemaker/Corosync

- Modificar a configuração do cluster enquanto ele está funcionando

- Configurar remotamente tanto Pacemaker e Corosync, quanto iniciar, parar e exibir informações de status do cluster

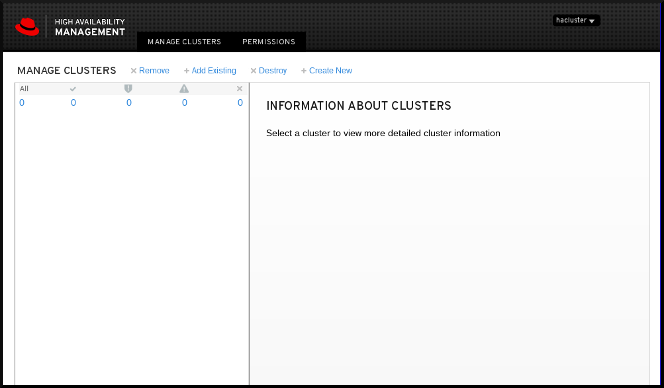

pcsdWeb UI- Uma interface gráfica do usuário para criar e configurar clusters Pacemaker/Corosync.

1.2.3. Os arquivos de configuração do cluster e do marcapasso

Os arquivos de configuração para o Red Hat High Availability Add-On são corosync.conf e cib.xml.

O arquivo corosync.conf fornece os parâmetros de cluster usados pelo corosync, o gerenciador de cluster em que a Pacemaker é construída. Em geral, você não deve editar o corosync.conf diretamente, mas, em vez disso, usar a interface pcs ou pcsd.

O arquivo cib.xml é um arquivo XML que representa tanto a configuração do cluster quanto o estado atual de todos os recursos no cluster. Este arquivo é utilizado pela Pacemaker's Cluster Information Base (CIB). O conteúdo da CIB é mantido automaticamente em sincronia em todo o cluster. Não edite o arquivo cib.xml diretamente; use a interface pcs ou pcsd em seu lugar.

1.3. Visão geral da vedação

Se a comunicação com um único nó do cluster falhar, então outros nós do cluster devem ser capazes de restringir ou liberar o acesso a recursos aos quais o nó de cluster falhado possa ter acesso. Isto não pode ser feito contatando o próprio nó de cluster, pois o nó de cluster pode não ser responsivo. Ao invés disso, deve-se fornecer um método externo, que é chamado de vedação com um agente de vedação. Um dispositivo de cerca é um dispositivo externo que pode ser usado pelo cluster para restringir o acesso a recursos compartilhados por um nó errante, ou para emitir uma reinicialização dura no nó de cluster.

Sem um dispositivo de cerca configurado, você não tem como saber que os recursos usados anteriormente pelo nó de cluster desconectado foram liberados, e isso poderia impedir que os serviços funcionassem em qualquer um dos outros nós de cluster. Por outro lado, o sistema pode assumir erroneamente que o nó de cluster liberou seus recursos e isto pode levar à corrupção e perda de dados. Sem um dispositivo de cerca, a integridade dos dados configurados não pode ser garantida e a configuração do cluster não será suportada.

Quando a vedação está em andamento, nenhuma outra operação de agrupamento é permitida. A operação normal do aglomerado não pode ser retomada até que a vedação tenha sido concluída ou o nó de aglomerado volte a juntar-se ao aglomerado depois que o nó de aglomerado tiver sido reinicializado.

Para mais informações sobre esgrima, consulte Esgrima em um Aglomerado de Alta Disponibilidade da Red Hat.

1.4. Visão geral do Quorum

A fim de manter a integridade e disponibilidade do cluster, os sistemas de cluster utilizam um conceito conhecido como quorum para evitar a corrupção e perda de dados. Um cluster tem quorum quando mais da metade dos nós do cluster estão on-line. Para mitigar a chance de corrupção de dados devido a falhas, o Pacemaker por padrão pára todos os recursos se o cluster não tiver quorum.

O Quorum é estabelecido usando um sistema de votação. Quando um nó de agrupamento não funciona como deveria ou perde a comunicação com o resto do agrupamento, os nós de trabalho da maioria podem votar para isolar e, se necessário, cercar o nó para manutenção.

Por exemplo, em um cluster de 6 nós, o quorum é estabelecido quando pelo menos 4 nós de cluster estão funcionando. Se a maioria dos nós ficar offline ou indisponível, o aglomerado não tem mais quórum e o Pacemaker pára os serviços de aglomeração.

As características do quorum em Pacemaker impedem o que também é conhecido como split-brain, um fenômeno onde o cluster é separado da comunicação, mas cada parte continua trabalhando como clusters separados, potencialmente escrevendo para os mesmos dados e possivelmente causando corrupção ou perda. Para mais informações sobre o que significa estar em um estado de cérebro dividido, e sobre conceitos de quórum em geral, veja Exploring Concepts of RHEL High Availability Clusters - Quorum.

Um cluster do Red Hat Enterprise Linux High Availability Add-On usa o serviço votequorum, em conjunto com a esgrima, para evitar situações de cérebro dividido. Um número de votos é atribuído a cada sistema no cluster, e as operações de cluster são permitidas somente quando uma maioria de votos está presente.

1.5. Visão geral dos recursos

A cluster resource é uma instância de programa, dados ou aplicação a ser gerenciada pelo serviço de cluster. Estes recursos são abstraídos por agents que fornecem uma interface padrão para gerenciar o recurso em um ambiente de cluster.

Para garantir que os recursos permaneçam saudáveis, você pode acrescentar uma operação de monitoramento à definição de um recurso. Se você não especificar uma operação de monitoramento para um recurso, uma é adicionada por padrão.

Você pode determinar o comportamento de um recurso em um cluster configurando constraints. Você pode configurar as seguintes categorias de restrições:

- restrições de localização

- restrições de pedidos

- restrições de colocação

Um dos elementos mais comuns de um agrupamento é um conjunto de recursos que precisam ser localizados juntos, começar sequencialmente e parar na ordem inversa. Para simplificar esta configuração, o Pacemaker apóia o conceito de groups.

1.6. Volumes lógicos LVM em um cluster de alta disponibilidade da Red Hat

O Red Hat High Availability Add-On oferece suporte para volumes LVM em duas configurações de cluster distintas:

- Volumes LVM de alta disponibilidade (HA-LVM) em configurações de failover ativo/passivo em que apenas um único nó do cluster acessa o armazenamento a qualquer momento.

-

Volumes LVM que utilizam o daemon

lvmlockdpara gerenciar dispositivos de armazenamento em configurações ativas/ativas nas quais mais de um nó do cluster requer acesso ao armazenamento ao mesmo tempo. O daemonlvmlockdfaz parte do Add-On de Armazenamento Resiliente.

1.6.1. Escolhendo HA-LVM ou volumes compartilhados

Quando usar o HA-LVM ou volumes lógicos compartilhados gerenciados pelo daemon lvmlockd devem ser baseados nas necessidades das aplicações ou serviços que estão sendo implantados.

-

Se vários nós do cluster requerem acesso simultâneo de leitura/escrita a volumes LVM em um sistema ativo/ativo, então você deve usar o daemon

lvmlockde configurar seus volumes como volumes compartilhados. O daemonlvmlockdfornece um sistema para coordenar a ativação e as mudanças nos volumes LVM entre os nós de um cluster simultaneamente. O serviço de travamento do daemonlvmlockdoferece proteção aos metadados do LVM à medida que vários nós do cluster interagem com os volumes e fazem alterações em seu layout. Esta proteção depende da configuração de qualquer grupo de volume que será ativado simultaneamente em vários nós de cluster como um volume compartilhado. -

Se o cluster de alta disponibilidade for configurado para gerenciar recursos compartilhados de forma ativa/passiva com apenas um único membro precisando de acesso a um determinado volume de LVM de cada vez, então você pode usar o HA-LVM sem o serviço de travamento

lvmlockd.

A maioria das aplicações funcionará melhor em uma configuração ativa/passiva, já que não são projetadas ou otimizadas para funcionar concomitantemente com outras instâncias. Optar por executar uma aplicação que não seja sensível a cluster em volumes lógicos compartilhados pode resultar em desempenho degradado. Isto ocorre porque há uma sobrecarga de comunicação em cluster para os próprios volumes lógicos nestas instâncias. Uma aplicação com consciência de cluster deve ser capaz de alcançar ganhos de desempenho acima das perdas de desempenho introduzidas pelos sistemas de arquivos de cluster e volumes lógicos com consciência de cluster. Isto é possível para algumas aplicações e cargas de trabalho mais facilmente do que para outras. Determinar quais são os requisitos do cluster e se o esforço extra para otimizar um cluster ativo/ativo trará dividendos é a maneira de escolher entre as duas variantes do LVM. A maioria dos usuários alcançará os melhores resultados HA com o uso do HA-LVM.

HA-LVM e volumes lógicos compartilhados usando lvmlockd são semelhantes no fato de que evitam a corrupção de metadados LVM e seus volumes lógicos, o que poderia ocorrer se várias máquinas fossem permitidas a fazer mudanças sobrepostas. O HA-LVM impõe a restrição de que um volume lógico só pode ser ativado exclusivamente; ou seja, ativo em apenas uma máquina de cada vez. Isto significa que somente implementações locais (não exclusivas) dos drivers de armazenamento são utilizadas. Evitar a sobrecarga de coordenação do cluster desta forma aumenta o desempenho. Um volume compartilhado usando lvmlockd não impõe estas restrições e um usuário é livre para ativar um volume lógico em todas as máquinas em um cluster; isto força o uso de drivers de armazenamento sensíveis ao cluster, que permitem que sistemas de arquivos e aplicações sensíveis ao cluster sejam colocados em cima.

1.6.2. Configuração de volumes LVM em um cluster

No Red Hat Enterprise Linux 8, os clusters são gerenciados através do Pacemaker. Tanto o HA-LVM quanto os volumes lógicos compartilhados são suportados somente em conjunto com os clusters Pacemaker, e devem ser configurados como recursos de cluster.

Para exemplos de procedimentos para configurar um volume HA-LVM como parte de um cluster Pacemaker, veja Configurando um servidor HTTP Apache ativo/passivo em um cluster Red Hat High Availability. e Configurando um servidor NFS ativo/passivo em um cluster Red Hat High Availability.

Observe que estes procedimentos incluem os seguintes passos:

- Assegurar que somente o agrupamento seja capaz de ativar o grupo de volume

- Configuração de um volume lógico LVM

- Configuração do volume da LVM como um recurso de cluster

-

Para um procedimento de configuração de volumes LVM compartilhados que utilizam o daemon

lvmlockdpara gerenciar dispositivos de armazenamento em configurações ativas/ativas, consulte Configuração de um sistema de arquivos GFS2 em um cluster

Capítulo 2. Começando com Pacemaker

Os seguintes procedimentos fornecem uma introdução às ferramentas e processos que você utiliza para criar um cluster Pacemaker. Eles são destinados aos usuários que estão interessados em ver como é o software do cluster e como ele é administrado, sem a necessidade de configurar um cluster funcional.

Estes procedimentos não criam um cluster Red Hat suportado, que requer pelo menos dois nós e a configuração de um dispositivo de esgrima.

2.1. Aprendendo a usar o Pacemaker

Este exemplo requer um único nó rodando RHEL 8 e requer um endereço IP flutuante que reside na mesma rede que um dos endereços IP atribuídos estaticamente a um dos nós.

-

O nó utilizado neste exemplo é

z1.example.com. - O endereço IP flutuante usado neste exemplo é 192.168.122.120.

Certifique-se de que o nome do nó em que você está rodando esteja em seu arquivo /etc/hosts.

Trabalhando através deste procedimento, você aprenderá como usar o Pacemaker para configurar um cluster, como exibir o status do cluster, e como configurar um serviço de cluster. Este exemplo cria um servidor HTTP Apache como um recurso de cluster e mostra como o cluster responde quando o recurso falha.

Instale os pacotes de software Red Hat High Availability Add-On a partir do canal High Availability, e inicie e habilite o serviço

pcsd.#

yum install pcs pacemaker fence-agents-all... #systemctl start pcsd.service#systemctl enable pcsd.serviceSe você estiver rodando o daemon

firewalld, habilite os portos que são exigidos pelo suplemento de alta disponibilidade da Red Hat.#

firewall-cmd --permanent --add-service=high-availability#firewall-cmd --reloadDefina uma senha para o usuário

haclusterem cada nó do cluster e autentique o usuáriohaclusterpara cada nó do cluster no nó a partir do qual você executará os comandospcs. Este exemplo está usando apenas um único nó, o nó a partir do qual você está executando os comandos, mas esta etapa está incluída aqui uma vez que é uma etapa necessária na configuração de um cluster multi-nó de alta disponibilidade compatível com a Red Hat High Availability.#

passwd hacluster... #pcs host auth z1.example.comCriar um agrupamento chamado

my_clustercom um membro e verificar o status do agrupamento. Este comando cria e inicia o agrupamento em uma única etapa.#

pcs cluster setup my_cluster --start z1.example.com... #pcs cluster statusCluster Status: Stack: corosync Current DC: z1.example.com (version 2.0.0-10.el8-b67d8d0de9) - partition with quorum Last updated: Thu Oct 11 16:11:18 2018 Last change: Thu Oct 11 16:11:00 2018 by hacluster via crmd on z1.example.com 1 node configured 0 resources configured PCSD Status: z1.example.com: OnlineUm aglomerado Red Hat High Availability requer que você configure a vedação para o aglomerado. As razões para esta exigência estão descritas em Esgrima em um Aglomerado de Alta Disponibilidade da Red Hat. Para esta introdução, entretanto, que se destina a mostrar apenas como usar os comandos básicos do Marcapasso, desabilite o cercado definindo a opção de cercado do

stonith-enabledparafalse.AtençãoO uso do

stonith-enabled=falseé completamente inadequado para um cluster de produção. Ele diz ao aglomerado para simplesmente fingir que os nós falhados estão cercados com segurança.#

pcs property set stonith-enabled=falseConfigure um navegador web em seu sistema e crie uma página web para exibir uma simples mensagem de texto. Se você estiver executando o daemon

firewalld, habilite as portas que são exigidas porhttpd.NotaNão utilize

systemctl enablepara permitir que quaisquer serviços que serão gerenciados pelo cluster comecem na inicialização do sistema.#

yum install -y httpd wget... #firewall-cmd --permanent --add-service=http#firewall-cmd --reload#cat <<-END >/var/www/html/index.html<html><body>My Test Site - $(hostname)</body></html>ENDPara que o agente de recursos Apache obtenha o status do Apache, crie a seguinte adição à configuração existente para habilitar a URL do servidor de status.

#

cat <<-END > /etc/httpd/conf.d/status.conf<Location /server-status>SetHandler server-statusOrder deny,allowDeny from allAllow from 127.0.0.1Allow from ::1</Location>ENDCrie recursos para o cluster

IPaddr2eapachepara gerenciá-lo. O recurso 'IPaddr2' é um endereço IP flutuante que não deve ser um já associado a um nó físico. Se o dispositivo NIC do recurso 'IPaddr2' não for especificado, o IP flutuante deve residir na mesma rede que o endereço IP estaticamente atribuído usado pelo nó.Você pode exibir uma lista de todos os tipos de recursos disponíveis com o comando

pcs resource list. Você pode usar o comandopcs resource describe resourcetypepara exibir os parâmetros que você pode definir para o tipo de recurso especificado. Por exemplo, o seguinte comando exibe os parâmetros que você pode definir para um recurso do tipoapache:#

pcs resource describe apache...Neste exemplo, o recurso de endereço IP e o recurso apache são ambos configurados como parte de um grupo chamado

apachegroup, o que garante que os recursos sejam mantidos juntos para funcionar no mesmo nó quando você estiver configurando um cluster de vários nós em funcionamento.#

pcs resource create ClusterIP ocf:heartbeat:IPaddr2 ip=192.168.122.120 --group apachegroup#pcs resource create WebSite ocf:heartbeat:apache configfile=/etc/httpd/conf/httpd.conf statusurl="http://localhost/server-status" --group apachegroup#pcs statusCluster name: my_cluster Stack: corosync Current DC: z1.example.com (version 2.0.0-10.el8-b67d8d0de9) - partition with quorum Last updated: Fri Oct 12 09:54:33 2018 Last change: Fri Oct 12 09:54:30 2018 by root via cibadmin on z1.example.com 1 node configured 2 resources configured Online: [ z1.example.com ] Full list of resources: Resource Group: apachegroup ClusterIP (ocf::heartbeat:IPaddr2): Started z1.example.com WebSite (ocf::heartbeat:apache): Started z1.example.com PCSD Status: z1.example.com: Online ...Após ter configurado um recurso de cluster, você pode usar o comando

pcs resource configpara exibir as opções que estão configuradas para aquele recurso.#

pcs resource config WebSiteResource: WebSite (class=ocf provider=heartbeat type=apache) Attributes: configfile=/etc/httpd/conf/httpd.conf statusurl=http://localhost/server-status Operations: start interval=0s timeout=40s (WebSite-start-interval-0s) stop interval=0s timeout=60s (WebSite-stop-interval-0s) monitor interval=1min (WebSite-monitor-interval-1min)- Aponte seu navegador para o site que você criou usando o endereço IP flutuante que você configurou. Isto deve exibir a mensagem de texto que você definiu.

Pare o serviço web apache e verifique o status do cluster. O uso do

killall -9simula uma falha em nível de aplicação.#

killall -9 httpdVerifique o status do agrupamento. Você deve ver que parar o serviço web causou uma ação fracassada, mas que o software de cluster reiniciou o serviço e você ainda deve ser capaz de acessar o site.

#

pcs statusCluster name: my_cluster ... Current DC: z1.example.com (version 1.1.13-10.el7-44eb2dd) - partition with quorum 1 node and 2 resources configured Online: [ z1.example.com ] Full list of resources: Resource Group: apachegroup ClusterIP (ocf::heartbeat:IPaddr2): Started z1.example.com WebSite (ocf::heartbeat:apache): Started z1.example.com Failed Resource Actions: * WebSite_monitor_60000 on z1.example.com 'not running' (7): call=13, status=complete, exitreason='none', last-rc-change='Thu Oct 11 23:45:50 2016', queued=0ms, exec=0ms PCSD Status: z1.example.com: OnlineVocê pode limpar o status de falha no recurso que falhou uma vez que o serviço esteja funcionando novamente e o aviso de falha de ação não aparecerá mais quando você visualizar o status do cluster.

#

pcs resource cleanup WebSiteQuando terminar de olhar o agrupamento e o status do agrupamento, pare os serviços de agrupamento no nó. Embora você só tenha iniciado os serviços em um nó para esta introdução, o parâmetro

--allestá incluído, pois pararia os serviços de cluster em todos os nós de um cluster real de vários nós.#

pcs cluster stop --all

2.2. Aprendendo a configurar o failover

Este procedimento fornece uma introdução à criação de um agrupamento de Pacemaker executando um serviço que irá falhar de um nó para outro quando o nó no qual o serviço está sendo executado se tornar indisponível. Trabalhando através deste procedimento, você pode aprender como criar um serviço em um cluster de dois nós e então você pode observar o que acontece com esse serviço quando ele falha no nó em que está rodando.

Este procedimento de exemplo configura um cluster de dois nós Pacemaker rodando um servidor Apache HTTP. Você pode então parar o serviço Apache em um nó para ver como o serviço permanece disponível.

Este procedimento requer como pré-requisito que você tenha dois nós rodando o Red Hat Enterprise Linux 8 que possam se comunicar um com o outro, e requer um endereço IP flutuante que resida na mesma rede que um dos endereços IP atribuídos estaticamente a um dos nós.

-

Os nós utilizados neste exemplo são

z1.example.comez2.example.com. - O endereço IP flutuante usado neste exemplo é 192.168.122.120.

Certifique-se de que os nomes dos nós que você está usando estão no arquivo /etc/hosts em cada nó.

Em ambos os nós, instalar os pacotes de software Red Hat High Availability Add-On do canal High Availability, e iniciar e habilitar o serviço

pcsd.#

yum install pcs pacemaker fence-agents-all... #systemctl start pcsd.service#systemctl enable pcsd.serviceSe você estiver rodando o daemon

firewalld, em ambos os nós habilite as portas que são exigidas pelo Add-On de Alta Disponibilidade da Red Hat.#

firewall-cmd --permanent --add-service=high-availability#firewall-cmd --reloadEm ambos os nós do cluster, defina uma senha para o usuário

hacluster.#

passwd haclusterAutentique o usuário

haclusterpara cada nó do cluster no nó a partir do qual você estará executando os comandospcs.#

pcs host auth z1.example.com z2.example.comCriar um cluster chamado

my_clustercom ambos os nós como membros do cluster. Este comando cria e inicia o agrupamento em uma única etapa. Você só precisa executar isto a partir de um nó no cluster porque os comandos de configuraçãopcsentram em vigor para o cluster inteiro.Em um nó em cluster, execute o seguinte comando.

#

pcs cluster setup my_cluster --start z1.example.com z2.example.comUm aglomerado Red Hat High Availability requer que você configure a vedação para o aglomerado. As razões para esta exigência estão descritas em Esgrima em um Aglomerado de Alta Disponibilidade da Red Hat. Para esta introdução, porém, para mostrar apenas como funciona o failover nesta configuração, desabilite a vedação definindo a opção de cluster

stonith-enabledparafalseAtençãoO uso do

stonith-enabled=falseé completamente inadequado para um cluster de produção. Ele diz ao aglomerado para simplesmente fingir que os nós falhados estão cercados com segurança.#

pcs property set stonith-enabled=falseApós criar um agrupamento e desativar a vedação, verifique o status do agrupamento.

NotaQuando você executa o comando

pcs cluster status, ele pode mostrar uma saída que difere temporariamente dos exemplos à medida que os componentes do sistema são iniciados.#

pcs cluster statusCluster Status: Stack: corosync Current DC: z1.example.com (version 2.0.0-10.el8-b67d8d0de9) - partition with quorum Last updated: Thu Oct 11 16:11:18 2018 Last change: Thu Oct 11 16:11:00 2018 by hacluster via crmd on z1.example.com 2 nodes configured 0 resources configured PCSD Status: z1.example.com: Online z2.example.com: OnlineEm ambos os nós, configure um navegador web e crie uma página web para exibir uma mensagem de texto simples. Se você estiver executando o daemon

firewalld, habilite as portas que são exigidas porhttpd.NotaNão utilize

systemctl enablepara permitir que quaisquer serviços que serão gerenciados pelo cluster comecem na inicialização do sistema.#

yum install -y httpd wget... #firewall-cmd --permanent --add-service=http#firewall-cmd --reload#cat <<-END >/var/www/html/index.html<html><body>My Test Site - $(hostname)</body></html>ENDPara que o agente de recursos Apache obtenha o status do Apache, em cada nó do cluster crie a seguinte adição à configuração existente para habilitar a URL do servidor de status.

#

cat <<-END > /etc/httpd/conf.d/status.conf<Location /server-status>SetHandler server-statusOrder deny,allowDeny from allAllow from 127.0.0.1Allow from ::1</Location>ENDCrie recursos para o cluster

IPaddr2eapachepara gerenciá-lo. O recurso 'IPaddr2' é um endereço IP flutuante que não deve ser um já associado a um nó físico. Se o dispositivo NIC do recurso 'IPaddr2' não for especificado, o IP flutuante deve residir na mesma rede que o endereço IP estaticamente atribuído usado pelo nó.Você pode exibir uma lista de todos os tipos de recursos disponíveis com o comando

pcs resource list. Você pode usar o comandopcs resource describe resourcetypepara exibir os parâmetros que você pode definir para o tipo de recurso especificado. Por exemplo, o seguinte comando exibe os parâmetros que você pode definir para um recurso do tipoapache:#

pcs resource describe apache...Neste exemplo, o recurso de endereço IP e o recurso apache são ambos configurados como parte de um grupo chamado

apachegroup, o que garante que os recursos sejam mantidos juntos para funcionar no mesmo nó.Execute os seguintes comandos a partir de um nó no aglomerado:

#

pcs resource create ClusterIP ocf:heartbeat:IPaddr2 ip=192.168.122.120 --group apachegroup#pcs resource create WebSite ocf:heartbeat:apache configfile=/etc/httpd/conf/httpd.conf statusurl="http://localhost/server-status" --group apachegroup#pcs statusCluster name: my_cluster Stack: corosync Current DC: z1.example.com (version 2.0.0-10.el8-b67d8d0de9) - partition with quorum Last updated: Fri Oct 12 09:54:33 2018 Last change: Fri Oct 12 09:54:30 2018 by root via cibadmin on z1.example.com 2 nodes configured 2 resources configured Online: [ z1.example.com z2.example.com ] Full list of resources: Resource Group: apachegroup ClusterIP (ocf::heartbeat:IPaddr2): Started z1.example.com WebSite (ocf::heartbeat:apache): Started z1.example.com PCSD Status: z1.example.com: Online z2.example.com: Online ...Note que, neste caso, o serviço

apachegroupestá rodando no nó z1.example.com.Acesse o site que você criou, pare o serviço no nó em que ele está funcionando e observe como o serviço falha até o segundo nó.

- Aponte um navegador para o site que você criou usando o endereço IP flutuante que você configurou. Isto deve exibir a mensagem de texto que você definiu, exibindo o nome do nó no qual o site está rodando.

Pare o serviço web apache. O uso do

killall -9simula uma falha no nível de aplicação.#

killall -9 httpdVerifique o status do agrupamento. Você deve ver que parar o serviço web causou uma ação falhada, mas que o software de cluster reiniciou o serviço no nó no qual ele estava rodando e você ainda deve ser capaz de acessar o navegador web.

#

pcs statusCluster name: my_cluster Stack: corosync Current DC: z1.example.com (version 2.0.0-10.el8-b67d8d0de9) - partition with quorum Last updated: Fri Oct 12 09:54:33 2018 Last change: Fri Oct 12 09:54:30 2018 by root via cibadmin on z1.example.com 2 nodes configured 2 resources configured Online: [ z1.example.com z2.example.com ] Full list of resources: Resource Group: apachegroup ClusterIP (ocf::heartbeat:IPaddr2): Started z1.example.com WebSite (ocf::heartbeat:apache): Started z1.example.com Failed Resource Actions: * WebSite_monitor_60000 on z1.example.com 'not running' (7): call=31, status=complete, exitreason='none', last-rc-change='Fri Feb 5 21:01:41 2016', queued=0ms, exec=0msLimpar o status de falha uma vez que o serviço esteja funcionando novamente.

#

pcs resource cleanup WebSiteColoque o nó sobre o qual o serviço está funcionando em modo de espera. Observe que, como desativamos a vedação, não podemos efetivamente simular uma falha no nível do aceno (como puxar um cabo de força) porque a vedação é necessária para que o aglomerado se recupere de tais situações.

#

pcs node standby z1.example.comVerifique o status do grupo e anote onde o serviço está funcionando agora.

#

pcs statusCluster name: my_cluster Stack: corosync Current DC: z1.example.com (version 2.0.0-10.el8-b67d8d0de9) - partition with quorum Last updated: Fri Oct 12 09:54:33 2018 Last change: Fri Oct 12 09:54:30 2018 by root via cibadmin on z1.example.com 2 nodes configured 2 resources configured Node z1.example.com: standby Online: [ z2.example.com ] Full list of resources: Resource Group: apachegroup ClusterIP (ocf::heartbeat:IPaddr2): Started z2.example.com WebSite (ocf::heartbeat:apache): Started z2.example.com- Acesse o site. Não deve haver perda de serviço, embora a mensagem de exibição deva indicar o nó em que o serviço está agora em execução.

Para restaurar os serviços de agrupamento para o primeiro nó, tire o nó do modo de espera. Isto não irá necessariamente mover o serviço de volta para aquele nó.

#

pcs node unstandby z1.example.comPara a limpeza final, pare os serviços de agrupamento em ambos os nós.

#

pcs cluster stop --all

Capítulo 3. A interface de linha de comando pcs

A interface de linha de comando pcs controla e configura serviços de cluster como corosync, pacemaker,booth, e sbd, fornecendo uma interface mais fácil para seus arquivos de configuração.

Note que você não deve editar o arquivo de configuração cib.xml diretamente. Na maioria dos casos, o Pacemaker rejeitará um arquivo cib.xml diretamente modificado.

3.1. pcs ajudam a exibir

Você pode usar a opção -h de pcs para exibir os parâmetros de um comando pcs e uma descrição desses parâmetros. Por exemplo, o comando a seguir exibe os parâmetros do comando pcs resource. Apenas uma parte da saída é mostrada.

# pcs resource -h3.2. Visualizando a configuração do cluster bruto

Embora você não deva editar o arquivo de configuração de cluster diretamente, você pode visualizar a configuração de cluster em bruto com o comando pcs cluster cib.

Você pode salvar a configuração do cluster bruto em um arquivo especificado com o pcs cluster cib filename comando. Se você tiver configurado previamente um cluster e já houver um CIB ativo, você usa o seguinte comando para salvar o arquivo xml bruto.

pcs cluster cib filename

Por exemplo, o seguinte comando salva o xml bruto da CIB em um arquivo chamado testfile.

pcs cluster cib test file

3.3. Salvando uma mudança de configuração para um arquivo de trabalho

Ao configurar um cluster, você pode salvar as alterações de configuração em um arquivo especificado sem afetar a CIB ativa. Isto permite que você especifique atualizações de configuração sem atualizar imediatamente a configuração de cluster em execução no momento com cada atualização individual.

Para informações sobre como salvar o CIB em um arquivo, consulte Visualização da configuração do cluster bruto. Uma vez criado esse arquivo, você pode salvar as alterações de configuração nesse arquivo em vez de na CIB ativa, usando a opção -f do comando pcs. Quando você tiver concluído as mudanças e estiver pronto para atualizar o arquivo CIB ativo, você pode empurrar essas atualizações de arquivo com o comando pcs cluster cib-push.

A seguir, o procedimento recomendado para empurrar mudanças no arquivo CIB. Este procedimento cria uma cópia do arquivo CIB original gravado e faz alterações nessa cópia. Ao empurrar essas alterações para o arquivo CIB ativo, este procedimento especifica a opção diff-against do comando pcs cluster cib-push para que somente as alterações entre o arquivo original e o arquivo atualizado sejam empurradas para o CIB. Isto permite que os usuários façam alterações em paralelo que não se sobrepõem e reduz a carga no Pacemaker que não precisa analisar o arquivo de configuração inteiro.

Salvar a CIB ativa em um arquivo. Este exemplo salva a CIB em um arquivo chamado

original.xml.#

pcs cluster cib original.xmlCopie o arquivo salvo para o arquivo de trabalho que você estará usando para as atualizações de configuração.

#

cp original.xml updated.xmlAtualize sua configuração conforme necessário. O seguinte comando cria um recurso no arquivo

updated.xml, mas não adiciona esse recurso à configuração de cluster atualmente em execução.#

pcs -f updated.xml resource create VirtualIP ocf:heartbeat:IPaddr2 ip=192.168.0.120 op monitor interval=30sEmpurre o arquivo atualizado para a CIB ativa, especificando que você está empurrando apenas as mudanças que fez no arquivo original.

#

pcs cluster cib-push updated.xml diff-against=original.xml

Alternativamente, você pode empurrar todo o conteúdo atual de um arquivo CIB com o seguinte comando.

pcs cluster cib-push filename

Ao empurrar o arquivo CIB inteiro, o Pacemaker verifica a versão e não permite que você empurre um arquivo CIB que seja mais antigo do que aquele já em um cluster. Se você precisar atualizar o arquivo CIB inteiro com uma versão mais antiga que a que está atualmente no cluster, você pode usar a opção --config do comando pcs cluster cib-push.

pcs cluster cib-push --config filename3.4. Exibição do status do cluster

Você pode exibir o status do agrupamento e os recursos do agrupamento com o seguinte comando.

status pcs

Você pode exibir o status de um determinado componente de cluster com o parâmetro commands do comando pcs status, especificando resources, cluster, nodes, ou pcsd.

status pcs commandsPor exemplo, o seguinte comando exibe o status dos recursos do cluster.

recursos de status pcs

O seguinte comando exibe o status do agrupamento, mas não os recursos do agrupamento.

pcs status de cluster

3.5. Exibição da configuração completa do cluster

Use o seguinte comando para exibir a configuração atual completa do cluster.

pcs config

Capítulo 4. Criando um cluster de Alta Disponibilidade Red Hat com Pacemaker

O seguinte procedimento cria um cluster de dois nós Red Hat High Availability usando pcs.

A configuração do cluster neste exemplo requer que seu sistema inclua os seguintes componentes:

-

2 nós, que serão usados para criar o agrupamento. Neste exemplo, os nós utilizados são

z1.example.comez2.example.com. - Comutadores de rede para a rede privada. Recomendamos, mas não exigimos uma rede privada para a comunicação entre os nós de cluster e outros equipamentos de cluster, tais como comutadores de energia de rede e comutadores de canal de fibra óptica.

-

Um dispositivo de vedação para cada nó do aglomerado. Este exemplo usa duas portas do interruptor de energia APC com um nome de host

zapc.example.com.

4.1. Instalação de software de cluster

O seguinte procedimento instala o software de cluster e configura seu sistema para a criação de clusters.

Em cada nó do cluster, instale os pacotes de software Red Hat High Availability Add-On junto com todos os agentes de vedação disponíveis no canal High Availability.

#

yum install pcs pacemaker fence-agents-allAlternativamente, você pode instalar os pacotes de software Red Hat High Availability Add-On junto com apenas o agente de vedação que você necessita com o seguinte comando.

#

yum install pcs pacemaker fence-agents-modelO comando a seguir exibe uma lista dos agentes de vedação disponíveis.

#

rpm -q -a | grep fencefence-agents-rhevm-4.0.2-3.el7.x86_64 fence-agents-ilo-mp-4.0.2-3.el7.x86_64 fence-agents-ipmilan-4.0.2-3.el7.x86_64 ...AtençãoApós instalar os pacotes Red Hat High Availability Add-On, você deve assegurar-se de que suas preferências de atualização de software estejam definidas para que nada seja instalado automaticamente. A instalação em um cluster em execução pode causar comportamentos inesperados. Para mais informações, consulte Práticas recomendadas para a aplicação de atualizações de software em um cluster de armazenamento RHEL de alta disponibilidade ou resiliente.

Se você estiver executando o daemon

firewalld, execute os seguintes comandos para habilitar as portas que são exigidas pelo Add-On de Alta Disponibilidade da Red Hat.NotaVocê pode determinar se o daemon

firewalldestá instalado em seu sistema com o comandorpm -q firewalld. Se ele estiver instalado, você pode determinar se ele está rodando com o comandofirewall-cmd --state.#

firewall-cmd --permanent --add-service=high-availability#firewall-cmd --add-service=high-availabilityNotaA configuração ideal de firewall para componentes de cluster depende do ambiente local, onde talvez seja necessário levar em conta considerações como, por exemplo, se os nós têm múltiplas interfaces de rede ou se há firewalls fora do host. O exemplo aqui, que abre as portas que são geralmente exigidas por um cluster Pacemaker, deve ser modificado para se adequar às condições locais. A habilitação de portas para o Add-On de Alta Disponibilidade mostra as portas para habilitar para o Add-On de Alta Disponibilidade da Red Hat e fornece uma explicação para o que cada porta é usada.

Para usar

pcspara configurar o cluster e se comunicar entre os nós, você deve definir uma senha em cada nó para o ID do usuáriohacluster, que é a conta de administraçãopcs. É recomendado que a senha para o usuáriohaclusterseja a mesma em cada nó.#

passwd haclusterChanging password for user hacluster. New password: Retype new password: passwd: all authentication tokens updated successfully.Antes que o cluster possa ser configurado, o daemon

pcsddeve ser iniciado e habilitado para iniciar na inicialização em cada nó. Este daemon trabalha com o comandopcspara gerenciar a configuração através dos nós do cluster.Em cada nó do cluster, execute os seguintes comandos para iniciar o serviço

pcsde para habilitarpcsdno início do sistema.#

systemctl start pcsd.service#systemctl enable pcsd.service

4.2. Instalação do pacote pcp-zeroconf (recomendado)

Ao configurar seu cluster, é recomendável instalar o pacote pcp-zeroconf para a ferramenta Performance Co-Pilot (PCP). O PCP é a ferramenta de monitoramento de recursos recomendada pela Red Hat para os sistemas RHEL. A instalação do pacote pcp-zeroconf permite que você tenha o PCP rodando e coletando dados de monitoramento de desempenho para o benefício de investigações sobre esgrima, falhas de recursos e outros eventos que perturbam o cluster.

As implantações de clusters onde o PCP é ativado precisarão de espaço suficiente disponível para os dados capturados do PCP no sistema de arquivos que contém /var/log/pcp/. O uso típico de espaço pelo PCP varia entre as implantações, mas 10Gb é normalmente suficiente quando se utiliza as configurações padrão pcp-zeroconf, e alguns ambientes podem requerer menos. O monitoramento do uso neste diretório durante um período de 14 dias de atividade típica pode fornecer uma expectativa de uso mais precisa.

Para instalar o pacote pcp-zeroconf, execute o seguinte comando.

# yum install pcp-zeroconf

Este pacote permite pmcd e estabelece a captura de dados em um intervalo de 10 segundos.

Para informações sobre a revisão de dados PCP, veja Por que um nó de cluster RHEL de alta disponibilidade foi reinicializado - e como posso evitar que isso aconteça novamente? no Portal do Cliente da Red Hat.

4.3. Criação de um cluster de alta disponibilidade

Este procedimento cria um cluster de Red Hat High Availability Add-On que consiste nos nós z1.example.com e z2.example.com.

Autentique o usuário

pcshaclusterpara cada nó do cluster no nó a partir do qual você estará rodandopcs.O seguinte comando autentica o usuário

haclusteremz1.example.compara os dois nós em um cluster de dois nós que consistirá dez1.example.comez2.example.com.[root@z1 ~]#

pcs host auth z1.example.com z2.example.comUsername:haclusterPassword: z1.example.com: Authorized z2.example.com: AuthorizedExecute o seguinte comando de

z1.example.compara criar o cluster de dois nósmy_clusterque consiste de nósz1.example.comez2.example.com. Isto propagará os arquivos de configuração do cluster para ambos os nós do cluster. Este comando inclui a opção--start, que iniciará os serviços de cluster em ambos os nós do cluster.[root@z1 ~]#

pcs cluster setup my_cluster --startz1.example.com z2.example.comPermitir que os serviços de cluster funcionem em cada nó do cluster quando o nó for inicializado.

NotaPara seu ambiente particular, você pode optar por deixar os serviços de cluster desativados, pulando esta etapa. Isto lhe permite assegurar que se um nó cair, quaisquer problemas com seu agrupamento ou seus recursos serão resolvidos antes que o nó se reintegre ao agrupamento. Se você deixar os serviços do cluster desativados, você precisará iniciar manualmente os serviços quando reiniciar um nó executando o comando

pcs cluster startnaquele nó.[root@z1 ~]#

pcs cluster enable --all

Você pode exibir o status atual do cluster com o comando pcs cluster status. Como pode haver um pequeno atraso antes que o cluster esteja pronto e funcionando quando você iniciar os serviços de cluster com a opção --start do comando pcs cluster setup, você deve assegurar que o cluster esteja pronto e funcionando antes de executar qualquer ação subseqüente sobre o cluster e sua configuração.

[root@z1 ~]# pcs cluster status

Cluster Status:

Stack: corosync

Current DC: z2.example.com (version 2.0.0-10.el8-b67d8d0de9) - partition with quorum

Last updated: Thu Oct 11 16:11:18 2018

Last change: Thu Oct 11 16:11:00 2018 by hacluster via crmd on z2.example.com

2 Nodes configured

0 Resources configured

...4.4. Criação de um cluster de alta disponibilidade com múltiplos links

Você pode usar o comando pcs cluster setup para criar um cluster Red Hat High Availability com múltiplos links, especificando todos os links para cada nó.

O formato do comando para criar um cluster de dois nós com dois links é o seguinte.

pcs cluster setup cluster_name node1_name addr=node1_link0_address addr=node1_link1_address node2_name addr=node2_link0_address addr=node2_link1_address

Ao criar um cluster com múltiplos links, você deve levar em conta o seguinte.

-

A ordem do

addr=addressparâmetros é importante. O primeiro endereço especificado após o nome de um nó é paralink0, o segundo paralink1, e assim por diante. - É possível especificar até oito ligações usando o protocolo de transporte de nós, que é o protocolo de transporte padrão.

-

Todos os nós devem ter o mesmo número de parâmetros

addr=. -

A partir do RHEL 8.1, é possível adicionar, remover e alterar links em um cluster existente usando os comandos

pcs cluster link add, opcs cluster link remove, opcs cluster link deletee opcs cluster link update. - Assim como nos clusters de link único, não misture endereços IPv4 e IPv6 em um link, embora você possa ter um link rodando IPv4 e o outro rodando IPv6.

- Como nos clusters de link único, você pode especificar endereços como endereços IP ou como nomes desde que os nomes resolvam para endereços IPv4 ou IPv6 para os quais endereços IPv4 e IPv6 não estejam misturados em um link.

O exemplo seguinte cria um cluster de dois nós chamado my_twolink_cluster com dois nós, rh80-node1 e rh80-node2. rh80-node1 tem duas interfaces, endereço IP 192.168.122.201 como link0 e 192.168.123.201 como link1. rh80-node2 tem duas interfaces, endereço IP 192.168.122.202 como link0 e 192.168.123.202 como link1.

# pcs cluster setup my_twolink_cluster rh80-node1 addr=192.168.122.201 addr=192.168.123.201 rh80-node2 addr=192.168.122.202 addr=192.168.123.202Para informações sobre como adicionar nós a um cluster existente com múltiplos links, consulte Adicionando um nó a um cluster com múltiplos links.

Para informações sobre como alterar os links em um cluster existente com múltiplos links, veja Adicionar e modificar links em um cluster existente.

4.5. Configuração de cercas

Você deve configurar um dispositivo de vedação para cada nó do aglomerado. Para informações sobre os comandos e opções de configuração da cerca, veja Configurando a cerca em um cluster de Alta Disponibilidade da Red Hat.

Para informações gerais sobre cercas e sua importância em um aglomerado de Red Hat High Availability, veja Fencing in a Red Hat High Availability Cluster.

Ao configurar um dispositivo de vedação, deve ser dada atenção se esse dispositivo compartilha energia com quaisquer nós ou dispositivos do cluster. Se um nó e seu dispositivo de cerca compartilham energia, então o aglomerado pode estar em risco de não poder cercar esse nó se a energia para ele e seu dispositivo de cerca forem perdidos. Tal aglomerado deve ter fontes de alimentação redundantes para os dispositivos e nós do cercado, ou dispositivos de cercado redundantes que não compartilham a energia. Métodos alternativos de vedação como SBD ou vedação de armazenamento também podem trazer redundância no caso de perdas isoladas de energia.

Este exemplo usa o interruptor de energia APC com um nome de host zapc.example.com para cercar os nós, e usa o agente de cercas fence_apc_snmp. Como ambos os nós serão vedados pelo mesmo agente de vedação, você pode configurar ambos os dispositivos de vedação como um único recurso, usando a opção pcmk_host_map.

Você cria um dispositivo de esgrima configurando o dispositivo como um recurso stonith com o comando pcs stonith create. O seguinte comando configura um recurso stonith chamado myapc que usa o agente de esgrima fence_apc_snmp para os nós z1.example.com e z2.example.com. A opção pcmk_host_map mapeia z1.example.com para a porta 1, e z2.example.com para a porta 2. O valor de login e a senha para o dispositivo APC são ambos apc. Por padrão, este dispositivo usará um intervalo de monitor de sessenta segundos para cada nó.

Observe que você pode usar um endereço IP ao especificar o nome do host para os nós.

[root@z1 ~]#pcs stonith create myapc fence_apc_snmp\ipaddr="zapc.example.com"\pcmk_host_map="z1.example.com:1;z2.example.com:2"\login="apc" passwd="apc"

O seguinte comando exibe os parâmetros de um dispositivo STONITH existente.

[root@rh7-1 ~]# pcs stonith config myapc

Resource: myapc (class=stonith type=fence_apc_snmp)

Attributes: ipaddr=zapc.example.com pcmk_host_map=z1.example.com:1;z2.example.com:2 login=apc passwd=apc

Operations: monitor interval=60s (myapc-monitor-interval-60s)Após configurar seu dispositivo de cerca, você deve testar o dispositivo. Para informações sobre como testar um dispositivo de cerca, veja Testar um dispositivo de cerca.

Não teste seu dispositivo de cercas desativando a interface de rede, pois isso não testará corretamente as cercas.

Uma vez configurada a vedação e iniciado um cluster, um reinício da rede acionará a vedação para o nó que reinicia a rede, mesmo quando o tempo limite não for ultrapassado. Por este motivo, não reinicie o serviço de rede enquanto o serviço de cluster estiver em funcionamento, pois ele acionará uma vedação não intencional no nó.

4.6. Apoio e restauração de uma configuração de cluster

Você pode fazer o backup da configuração do cluster em uma tarball com o seguinte comando. Se você não especificar um nome de arquivo, será usada a saída padrão.

pcs config backup filename

O comando pcs config backup faz backup apenas da própria configuração do cluster conforme configurado no CIB; a configuração dos daemons de recursos está fora do escopo deste comando. Por exemplo, se você tiver configurado um recurso Apache no cluster, as configurações do recurso (que estão na CIB) serão copiadas, enquanto as configurações do daemon Apache (como definido em`/etc/httpd`) e os arquivos que ele serve não serão copiados. Da mesma forma, se houver um recurso de banco de dados configurado no cluster, o banco de dados em si não será feito o backup, enquanto a configuração do recurso de banco de dados (CIB) será feita.

Use o seguinte comando para restaurar os arquivos de configuração de cluster em todos os nós a partir do backup. Se você não especificar um nome de arquivo, será usada a entrada padrão. Especificar a opção --local restaura somente os arquivos no nó atual.

pcs config restore [--local] [filename]4.7. Habilitação de portas para o Add-On de Alta Disponibilidade

A configuração ideal de firewall para componentes de cluster depende do ambiente local, onde talvez seja necessário levar em conta considerações como, por exemplo, se os nós têm múltiplas interfaces de rede ou se há firewalls fora do host.

Se você estiver executando o daemon firewalld, execute os seguintes comandos para habilitar as portas que são exigidas pelo Add-On de Alta Disponibilidade da Red Hat.

#firewall-cmd --permanent --add-service=high-availability#firewall-cmd --add-service=high-availability

Talvez seja necessário modificar quais portos estão abertos para atender às condições locais.

Você pode determinar se o daemon firewalld está instalado em seu sistema com o comando rpm -q firewalld. Se o daemon firewalld estiver instalado, você pode determinar se ele está rodando com o comando firewall-cmd --state.

Tabela 4.1, “Portos que possibilitam um suplemento de alta disponibilidade” mostra os portos a serem habilitados para o Red Hat High Availability Add-On e fornece uma explicação para o que o porto é usado.

Tabela 4.1. Portos que possibilitam um suplemento de alta disponibilidade

| Porto | Quando necessário |

|---|---|

| TCP 2224 |

Padrão

É crucial abrir a porta 2224 de tal forma que |

| TCP 3121 | Necessário em todos os nós se o agrupamento tiver algum nó de Pacemaker Remote

O daemon do Pacemaker |

| TCP 5403 |

Necessário no quorum quando se utiliza um dispositivo de quorum com |

| UDP 5404-5412 |

Necessário nos nós corosync para facilitar a comunicação entre os nós. É crucial abrir as portas 5404-5412 de tal forma que |

| TCP 21064 |

Necessário em todos os nós se o cluster contiver algum recurso que requeira DLM (como |

| TCP 9929, UDP 9929 | É necessário estar aberto em todos os nós de cluster e nós árbitros de estande para conexões de qualquer um desses mesmos nós quando o gerente de bilhetes do estande é usado para estabelecer um cluster com vários locais. |

Capítulo 5. Configuração de um servidor HTTP Apache ativo/passivo em um cluster Red Hat High Availability

O seguinte procedimento configura um servidor Apache HTTP ativo/passivo em um cluster de dois nós Red Hat Enterprise Linux High Availability Add-On usando pcs para configurar recursos de cluster. Neste caso de uso, os clientes acessam o servidor Apache HTTP através de um endereço IP flutuante. O servidor web roda em um dos dois nós do cluster. Se o nó no qual o servidor web está rodando ficar inoperante, o servidor web inicia novamente no segundo nó do cluster com interrupção mínima do serviço.

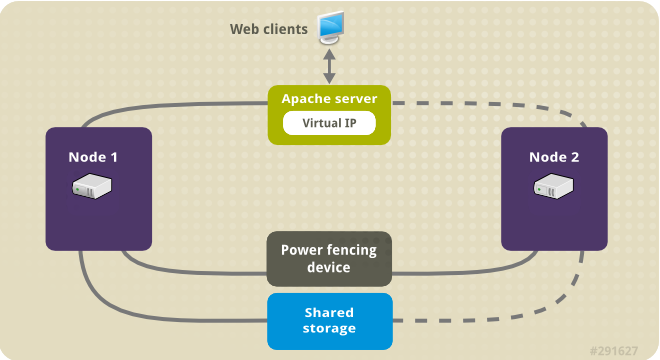

Figura 5.1, “Apache em um grupo de dois nós de alta disponibilidade de chapéu vermelho” mostra uma visão geral de alto nível do cluster no qual O cluster é um cluster de dois nós Red Hat High Availability configurado com um switch de energia de rede e com armazenamento compartilhado. Os nós do cluster são conectados a uma rede pública, para acesso do cliente ao servidor HTTP Apache através de um IP virtual. O servidor Apache roda no Nó 1 ou no Nó 2, cada um dos quais tem acesso ao armazenamento no qual os dados do Apache são mantidos. Nesta ilustração, o servidor web está rodando no Nó 1, enquanto o Nó 2 está disponível para rodar o servidor caso o Nó 1 se torne inoperante.

Figura 5.1. Apache em um grupo de dois nós de alta disponibilidade de chapéu vermelho

Este caso de uso requer que seu sistema inclua os seguintes componentes:

- Um cluster de dois nós Red Hat High Availability com vedação de energia configurada para cada nó. Recomendamos, mas não exigimos uma rede privada. Este procedimento utiliza o exemplo de cluster fornecido em Criar um cluster Red Hat High-Availability com Pacemaker.

- Um endereço IP virtual público, necessário para o Apache.

- Armazenamento compartilhado para os nós do cluster, utilizando iSCSI, Fibre Channel ou outro dispositivo de bloco de rede compartilhado.

O cluster é configurado com um grupo de recursos Apache, que contém os componentes do cluster que o servidor web requer: um recurso LVM, um recurso de sistema de arquivos, um recurso de endereço IP e um recurso de servidor web. Este grupo de recursos pode falhar de um nó do cluster para o outro, permitindo que qualquer um dos nós execute o servidor web. Antes de criar o grupo de recursos para este cluster, você estará executando os seguintes procedimentos:

-

Configurar um sistema de arquivo

ext4no volume lógicomy_lv. - Configurar um servidor web.

Depois de executar estas etapas, você cria o grupo de recursos e os recursos que ele contém.

5.1. Configuração de um volume LVM com um sistema de arquivo ext4 em um cluster Pacemaker

Este caso de uso requer a criação de um volume lógico LVM no armazenamento que é compartilhado entre os nós do cluster.

Os volumes LVM e as partições e dispositivos correspondentes usados pelos nós de cluster devem ser conectados somente aos nós de cluster.

O procedimento seguinte cria um volume lógico LVM e depois cria um sistema de arquivo ext4 nesse volume para uso em um cluster de Pacemaker. Neste exemplo, a partição compartilhada /dev/sdb1 é usada para armazenar o volume físico LVM a partir do qual o volume lógico LVM será criado.

Em ambos os nós do cluster, executar os seguintes passos para definir o valor para o ID do sistema LVM para o valor do identificador

unamepara o sistema. O ID do sistema LVM será usado para garantir que somente o cluster seja capaz de ativar o grupo de volume.Defina a opção de configuração

system_id_sourceno arquivo de configuração/etc/lvm/lvm.confparauname.# Configuration option global/system_id_source. system_id_source = "uname"

Verificar se o ID do sistema LVM no nó corresponde ao

unamepara o nó.#

lvm systemidsystem ID: z1.example.com #uname -nz1.example.com

Criar o volume LVM e criar um sistema de arquivo ext4 sobre esse volume. Uma vez que a partição

/dev/sdb1é o armazenamento compartilhado, esta parte do procedimento é realizada em apenas um nó.Criar um volume físico LVM na partição

/dev/sdb1.#

pvcreate /dev/sdb1Physical volume "/dev/sdb1" successfully createdCriar o grupo de volume

my_vgque consiste no volume físico/dev/sdb1.#

vgcreate my_vg /dev/sdb1Volume group "my_vg" successfully createdVerifique se o novo grupo de volume tem a identificação do sistema do nó no qual você está rodando e a partir do qual você criou o grupo de volume.

#

vgs -o+systemidVG #PV #LV #SN Attr VSize VFree System ID my_vg 1 0 0 wz--n- <1.82t <1.82t z1.example.comCriar um volume lógico utilizando o grupo de volume

my_vg.#

lvcreate -L450 -n my_lv my_vgRounding up size to full physical extent 452.00 MiB Logical volume "my_lv" createdVocê pode usar o comando

lvspara exibir o volume lógico.#

lvsLV VG Attr LSize Pool Origin Data% Move Log Copy% Convert my_lv my_vg -wi-a---- 452.00m ...Criar um sistema de arquivo ext4 no volume lógico

my_lv.#

mkfs.ext4 /dev/my_vg/my_lvmke2fs 1.44.3 (10-July-2018) Creating filesystem with 462848 1k blocks and 115824 inodes ...

5.2. Configuração de um Servidor HTTP Apache

O seguinte procedimento configura um Servidor HTTP Apache.

Garantir que o Servidor HTTP Apache esteja instalado em cada nó do cluster. Você também precisa da ferramenta

wgetinstalada no cluster para poder verificar o status do Servidor HTTP Apache.Em cada nó, executar o seguinte comando.

#

yum install -y httpd wgetSe você estiver rodando o daemon

firewalld, em cada nó do cluster habilite as portas que são exigidas pelo Add-On de Alta Disponibilidade da Red Hat.#

firewall-cmd --permanent --add-service=high-availability#firewall-cmd --reloadPara que o agente de recursos Apache obtenha o status do Servidor HTTP Apache, certifique-se de que o seguinte texto esteja presente no arquivo

/etc/httpd/conf/httpd.confem cada nó do cluster, e certifique-se de que ele não tenha sido comentado. Se este texto ainda não estiver presente, adicione o texto ao final do arquivo.<Location /server-status> SetHandler server-status Require local </Location>Quando você usa o agente de recursos

apachepara gerenciar o Apache, ele não usasystemd. Por causa disso, você deve editar o scriptlogrotatefornecido com o Apache para que ele não utilizesystemctlpara recarregar o Apache.Remova a seguinte linha no arquivo

/etc/logrotate.d/httpdem cada nó do cluster./bin/systemctl reload httpd.service > /dev/null 2>/dev/null || true

Substitua a linha que você removeu pelas três linhas a seguir.

/usr/bin/test -f /run/httpd.pid >/dev/null 2>/dev/null && /usr/bin/ps -q $(/usr/bin/cat /run/httpd.pid) >/dev/null 2>/dev/null && /usr/sbin/httpd -f /etc/httpd/conf/httpd.conf \ -c "PidFile /run/httpd.pid" -k graceful > /dev/null 2>/dev/null || true

Criar uma página web para que o Apache possa servir. Em um nó do cluster, monte o sistema de arquivo que você criou em Configurando um volume LVM com um sistema de arquivo ext4, crie o arquivo

index.htmlnesse sistema de arquivo, e depois desmonte o sistema de arquivo.#

mount /dev/my_vg/my_lv /var/www/#mkdir /var/www/html#mkdir /var/www/cgi-bin#mkdir /var/www/error#restorecon -R /var/www#cat <<-END >/var/www/html/index.html<html><body>Hello</body></html>END#umount /var/www

5.3. Criação dos recursos e grupos de recursos

Este caso de uso requer que você crie quatro recursos de cluster. Para garantir que todos esses recursos funcionem no mesmo nó, eles são configurados como parte do grupo de recursos apachegroup. Os recursos a serem criados são os seguintes, listados na ordem em que serão iniciados.

-

Um recurso

LVMchamadomy_lvmque usa o grupo de volume LVM que você criou em Configurar um volume LVM com um sistema de arquivo ext4. -

Um recurso

Filesystemchamadomy_fs, que usa o dispositivo de sistema de arquivo/dev/my_vg/my_lvque você criou em Configurando um volume LVM com um sistema de arquivo ext4. -

Um recurso

IPaddr2, que é um endereço IP flutuante para o grupo de recursosapachegroup. O endereço IP não deve ser um endereço já associado a um nó físico. Se o dispositivo NIC do recursoIPaddr2não for especificado, o IP flutuante deve residir na mesma rede que um dos endereços IP do nó estaticamente atribuído, caso contrário o dispositivo NIC para atribuir o endereço IP flutuante não poderá ser detectado corretamente. -

Um recurso

apachechamadoWebsiteque usa o arquivoindex.htmle a configuração do Apache que você definiu em Configurando um servidor Apache HTTP.

O seguinte procedimento cria o grupo de recursos apachegroup e os recursos que o grupo contém. Os recursos começarão na ordem em que são adicionados ao grupo, e pararão na ordem inversa em que são adicionados ao grupo. Execute este procedimento a partir de um único nó do grupo.

O seguinte comando cria o recurso

LVM-activatemy_lvm. Como o grupo de recursosapachegroupainda não existe, este comando cria o grupo de recursos.NotaNão configure mais de um recurso

LVM-activateque utiliza o mesmo grupo de volume LVM em uma configuração HA ativa/passiva, pois isso poderia causar corrupção de dados. Além disso, não configure um recursoLVM-activatecomo um recurso clone em uma configuração de HA ativa/passiva.[root@z1 ~]#

pcs resource create my_lvm ocf:heartbeat:LVM-activatevgname=my_vgvg_access_mode=system_id --group apachegroupQuando você cria um recurso, o recurso é iniciado automaticamente. Você pode usar o seguinte comando para confirmar que o recurso foi criado e foi iniciado.

#

pcs resource statusResource Group: apachegroup my_lvm (ocf::heartbeat:LVM-activate): StartedVocê pode parar e iniciar manualmente um recurso individual com os comandos

pcs resource disableepcs resource enable.Os seguintes comandos criam os recursos restantes para a configuração, adicionando-os ao grupo de recursos existentes

apachegroup.[root@z1 ~]#

pcs resource create my_fs Filesystem\device="/dev/my_vg/my_lv" directory="/var/www" fstype="ext4"\--group apachegroup[root@z1 ~]#pcs resource create VirtualIP IPaddr2 ip=198.51.100.3\cidr_netmask=24 --group apachegroup[root@z1 ~]#pcs resource create Website apache\configfile="/etc/httpd/conf/httpd.conf"\statusurl="http://127.0.0.1/server-status" --group apachegroupDepois de criar os recursos e o grupo de recursos que os contém, você pode verificar o status do agrupamento. Observe que todos os quatro recursos estão funcionando no mesmo nó.

[root@z1 ~]#

pcs statusCluster name: my_cluster Last updated: Wed Jul 31 16:38:51 2013 Last change: Wed Jul 31 16:42:14 2013 via crm_attribute on z1.example.com Stack: corosync Current DC: z2.example.com (2) - partition with quorum Version: 1.1.10-5.el7-9abe687 2 Nodes configured 6 Resources configured Online: [ z1.example.com z2.example.com ] Full list of resources: myapc (stonith:fence_apc_snmp): Started z1.example.com Resource Group: apachegroup my_lvm (ocf::heartbeat:LVM): Started z1.example.com my_fs (ocf::heartbeat:Filesystem): Started z1.example.com VirtualIP (ocf::heartbeat:IPaddr2): Started z1.example.com Website (ocf::heartbeat:apache): Started z1.example.comObserve que se você não tiver configurado um dispositivo de esgrima para seu cluster, por padrão os recursos não começam.

Uma vez que o cluster esteja instalado e funcionando, você pode apontar um navegador para o endereço IP que você definiu como o recurso

IPaddr2para visualizar a exibição da amostra, que consiste na simples palavra "Olá".Olá

Se você descobrir que os recursos que você configurou não estão funcionando, você pode executar o

pcs resource debug-start resourcecomando para testar a configuração do recurso.

5.4. Teste da configuração dos recursos

Na exibição do status do cluster mostrada em Criando os recursos e grupos de recursos, todos os recursos estão rodando no nó z1.example.com. Você pode testar se o grupo de recursos falha no nó z2.example.com usando o seguinte procedimento para colocar o primeiro nó no modo standby, após o qual o nó não será mais capaz de hospedar recursos.

O seguinte comando coloca o nó

z1.example.comno modostandby.[root@z1 ~]#

pcs node standby z1.example.comApós colocar o nó

z1no modostandby, verifique o status do agrupamento. Observe que agora todos os recursos devem estar funcionando emz2.[root@z1 ~]#

pcs statusCluster name: my_cluster Last updated: Wed Jul 31 17:16:17 2013 Last change: Wed Jul 31 17:18:34 2013 via crm_attribute on z1.example.com Stack: corosync Current DC: z2.example.com (2) - partition with quorum Version: 1.1.10-5.el7-9abe687 2 Nodes configured 6 Resources configured Node z1.example.com (1): standby Online: [ z2.example.com ] Full list of resources: myapc (stonith:fence_apc_snmp): Started z1.example.com Resource Group: apachegroup my_lvm (ocf::heartbeat:LVM): Started z2.example.com my_fs (ocf::heartbeat:Filesystem): Started z2.example.com VirtualIP (ocf::heartbeat:IPaddr2): Started z2.example.com Website (ocf::heartbeat:apache): Started z2.example.comO site no endereço IP definido ainda deve ser exibido, sem interrupção.

Para remover

z1do modostandby, digite o seguinte comando.[root@z1 ~]#

pcs node unstandby z1.example.comNotaA remoção de um nó do modo

standbynão faz com que os recursos, por si só, falhem de volta a esse nó. Isto dependerá do valorresource-stickinesspara os recursos. Para informações sobre o meta atributoresource-stickiness, consulte Configurando um recurso para preferir seu nó atual.

Capítulo 6. Configuração de um servidor NFS ativo/passivo em um cluster Red Hat High Availability

O procedimento a seguir configura um servidor NFS ativo/passivo altamente disponível em um cluster de dois nós Red Hat Enterprise Linux High Availability Add-On usando armazenamento compartilhado. O procedimento usa pcs para configurar os recursos de cluster do Pacemaker. Neste caso de uso, os clientes acessam o sistema de arquivo NFS através de um endereço IP flutuante. O servidor NFS roda em um dos dois nós do cluster. Se o nó no qual o servidor NFS está rodando se torna inoperante, o servidor NFS inicia novamente no segundo nó do cluster com interrupção mínima do serviço.

6.1. Pré-requisitos

Este caso de uso requer que seu sistema inclua os seguintes componentes:

- Um cluster de dois nós Red Hat High Availability com vedação de energia configurada para cada nó. Recomendamos, mas não exigimos uma rede privada. Este procedimento utiliza o exemplo de cluster fornecido em Criar um cluster Red Hat High-Availability com Pacemaker.

- Um endereço IP virtual público, necessário para o servidor NFS.

- Armazenamento compartilhado para os nós do cluster, utilizando iSCSI, Fibre Channel ou outro dispositivo de bloco de rede compartilhado.

6.2. Visão geral dos procedimentos

A configuração de um servidor NFS ativo/passivo altamente disponível em um cluster Red Hat Enterprise Linux High Availability de dois nós já existente requer que você execute os seguintes passos:

-

Configurar um sistema de arquivo

ext4no volume lógico do LVMmy_lvsobre o armazenamento compartilhado para os nós no cluster. - Configurar um compartilhamento NFS sobre o armazenamento compartilhado no volume lógico LVM.

- Criar os recursos do cluster.

- Teste o servidor NFS que você configurou.

6.3. Configuração de um volume LVM com um sistema de arquivo ext4 em um cluster Pacemaker

Este caso de uso requer a criação de um volume lógico LVM no armazenamento que é compartilhado entre os nós do cluster.

Os volumes LVM e as partições e dispositivos correspondentes usados pelos nós de cluster devem ser conectados somente aos nós de cluster.

O procedimento seguinte cria um volume lógico LVM e depois cria um sistema de arquivo ext4 nesse volume para uso em um cluster de Pacemaker. Neste exemplo, a partição compartilhada /dev/sdb1 é usada para armazenar o volume físico LVM a partir do qual o volume lógico LVM será criado.

Em ambos os nós do cluster, executar os seguintes passos para definir o valor para o ID do sistema LVM para o valor do identificador

unamepara o sistema. O ID do sistema LVM será usado para garantir que somente o cluster seja capaz de ativar o grupo de volume.Defina a opção de configuração

system_id_sourceno arquivo de configuração/etc/lvm/lvm.confparauname.# Configuration option global/system_id_source. system_id_source = "uname"

Verificar se o ID do sistema LVM no nó corresponde ao

unamepara o nó.#

lvm systemidsystem ID: z1.example.com #uname -nz1.example.com

Criar o volume LVM e criar um sistema de arquivo ext4 sobre esse volume. Uma vez que a partição

/dev/sdb1é o armazenamento compartilhado, esta parte do procedimento é realizada em apenas um nó.Criar um volume físico LVM na partição

/dev/sdb1.#

pvcreate /dev/sdb1Physical volume "/dev/sdb1" successfully createdCriar o grupo de volume

my_vgque consiste no volume físico/dev/sdb1.#

vgcreate my_vg /dev/sdb1Volume group "my_vg" successfully createdVerifique se o novo grupo de volume tem a identificação do sistema do nó no qual você está rodando e a partir do qual você criou o grupo de volume.

#

vgs -o+systemidVG #PV #LV #SN Attr VSize VFree System ID my_vg 1 0 0 wz--n- <1.82t <1.82t z1.example.comCriar um volume lógico utilizando o grupo de volume

my_vg.#

lvcreate -L450 -n my_lv my_vgRounding up size to full physical extent 452.00 MiB Logical volume "my_lv" createdVocê pode usar o comando

lvspara exibir o volume lógico.#

lvsLV VG Attr LSize Pool Origin Data% Move Log Copy% Convert my_lv my_vg -wi-a---- 452.00m ...Criar um sistema de arquivo ext4 no volume lógico

my_lv.#

mkfs.ext4 /dev/my_vg/my_lvmke2fs 1.44.3 (10-July-2018) Creating filesystem with 462848 1k blocks and 115824 inodes ...

6.4. Configuração de um compartilhamento NFS

O procedimento a seguir configura o compartilhamento do NFS para o failover do serviço NFS.

Em ambos os nós do cluster, criar o diretório

/nfsshare.#

mkdir /nfsshareEm um nó do agrupamento, realizar o seguinte procedimento.

Monte o sistema de arquivo ext4 que você criou em Configurando um volume LVM com um sistema de arquivo ext4 no diretório

/nfsshare.[root@z1 ~]#

mount /dev/my_vg/my_lv /nfsshareCriar uma árvore de diretório

exportsno diretório/nfsshare.[root@z1 ~]#

mkdir -p /nfsshare/exports[root@z1 ~]#mkdir -p /nfsshare/exports/export1[root@z1 ~]#mkdir -p /nfsshare/exports/export2Coloque os arquivos no diretório

exportspara que os clientes do NFS tenham acesso. Para este exemplo, estamos criando arquivos de teste chamadosclientdatafile1eclientdatafile2.[root@z1 ~]#

touch /nfsshare/exports/export1/clientdatafile1[root@z1 ~]#touch /nfsshare/exports/export2/clientdatafile2Desmontar o sistema de arquivo ext4 e desativar o grupo de volume LVM.

[root@z1 ~]#

umount /dev/my_vg/my_lv[root@z1 ~]#vgchange -an my_vg

6.5. Configuração dos recursos e grupo de recursos para um servidor NFS em um cluster

Esta seção fornece o procedimento para configurar os recursos do cluster para este caso de uso.

Se você não tiver configurado um dispositivo de esgrima para seu cluster, por padrão os recursos não começam.

Se você descobrir que os recursos que você configurou não estão funcionando, você pode executar o pcs resource debug-start resource comando para testar a configuração do recurso. Isto inicia o serviço fora do controle e do conhecimento do cluster. No ponto em que os recursos configurados estão rodando novamente, executar pcs resource cleanup resource para que o grupo tome conhecimento das atualizações.

O procedimento a seguir configura os recursos do sistema. Para garantir que todos estes recursos funcionem no mesmo nó, eles são configurados como parte do grupo de recursos nfsgroup. Os recursos começarão na ordem em que são adicionados ao grupo, e pararão na ordem inversa em que são adicionados ao grupo. Execute este procedimento a partir de um único nó do grupo.

Criar o recurso LVM-activate chamado

my_lvm. Como o grupo de recursosnfsgroupainda não existe, este comando cria o grupo de recursos.AtençãoNão configure mais de um recurso

LVM-activateque utiliza o mesmo grupo de volume LVM em uma configuração HA ativa/passiva, pois isso corre o risco de corrupção de dados. Além disso, não configure um recursoLVM-activatecomo um recurso clone em uma configuração de HA ativa/passiva.[root@z1 ~]#

pcs resource create my_lvm ocf:heartbeat:LVM-activatevgname=my_vgvg_access_mode=system_id --group nfsgroupVerifique o status do agrupamento para verificar se o recurso está funcionando.

root@z1 ~]#

pcs statusCluster name: my_cluster Last updated: Thu Jan 8 11:13:17 2015 Last change: Thu Jan 8 11:13:08 2015 Stack: corosync Current DC: z2.example.com (2) - partition with quorum Version: 1.1.12-a14efad 2 Nodes configured 3 Resources configured Online: [ z1.example.com z2.example.com ] Full list of resources: myapc (stonith:fence_apc_snmp): Started z1.example.com Resource Group: nfsgroup my_lvm (ocf::heartbeat:LVM): Started z1.example.com PCSD Status: z1.example.com: Online z2.example.com: Online Daemon Status: corosync: active/enabled pacemaker: active/enabled pcsd: active/enabledConfigurar um recurso

Filesystempara o cluster.O seguinte comando configura um recurso ext4

Filesystemchamadonfssharecomo parte do grupo de recursosnfsgroup. Este sistema de arquivo usa o grupo de volume LVM e o sistema de arquivo ext4 que você criou em Configuring an LVM volume with an ext4 file system e será montado no diretório/nfsshareque você criou em Configuring an NFS share.[root@z1 ~]#

pcs resource create nfsshare Filesystem\device=/dev/my_vg/my_lv directory=/nfsshare\fstype=ext4 --group nfsgroupVocê pode especificar opções de montagem como parte da configuração do recurso para um recurso

Filesystemcom ooptions=optionsparâmetro. Execute o comandopcs resource describe Filesystempara opções de configuração completa.Verifique se os recursos

my_lvmenfsshareestão funcionando.[root@z1 ~]#

pcs status... Full list of resources: myapc (stonith:fence_apc_snmp): Started z1.example.com Resource Group: nfsgroup my_lvm (ocf::heartbeat:LVM): Started z1.example.com nfsshare (ocf::heartbeat:Filesystem): Started z1.example.com ...Criar o recurso

nfsserverchamadonfs-daemoncomo parte do grupo de recursosnfsgroup.NotaO recurso

nfsserverpermite especificar um parâmetronfs_shared_infodir, que é um diretório que os servidores NFS usam para armazenar informações de estado relacionadas ao NFS.Recomenda-se que este atributo seja definido em um subdiretório de um dos recursos

Filesystemque você criou nesta coleção de exportações. Isto garante que os servidores NFS estejam armazenando suas informações de estado em um dispositivo que ficará disponível para outro nó se este grupo de recursos precisar se relocalizar. Neste exemplo;-

/nfsshareé o diretório de armazéns compartilhados gerenciado pelo recursoFilesystem -

/nfsshare/exports/export1e/nfsshare/exports/export2são os diretórios de exportação -

/nfsshare/nfsinfoé o diretório de informações compartilhadas para o recursonfsserver

[root@z1 ~]#

pcs resource create nfs-daemon nfsserver\nfs_shared_infodir=/nfsshare/nfsinfo nfs_no_notify=true\--group nfsgroup[root@z1 ~]#pcs status...-

Adicione os recursos de