Red Hat Training

A Red Hat training course is available for Red Hat Virtualization

설치 가이드

Red Hat Virtualization 설치

초록

I 부. Red Hat Virtualization 소개

1장. Red Hat Virtualization 소개

- Red Hat Virtualization Manager 설치 및 설정

- 호스트 설치 및 설정

- 기존 FCP 스토리지를 Red Hat Virtualization 환경에 연결. 기타 스토리지 옵션은 관리 가이드를 참조하십시오.

표 1.1. Red Hat Virtualization 주요 구성 요소

| 구성 요소 | 설명 |

|---|---|

| Red Hat Virtualization Manager | 환경 내에서 리소스를 관리하고 액세스를 제공하는 서버 |

| 호스트 | 가상 머신을 실행하는 데 사용되는 처리 기능과 메모리 리소스를 제공하는 서버 |

| 스토리지 | 가상 머신과 연결된 데이터 저장에 사용되는 스토리지 |

중요

2장. 시스템 요구 사항

2.1. Red Hat Virtualization Manager 요구 사항

2.1.1. 하드웨어 요구 사항

표 2.1. Red Hat Virtualization Manager 하드웨어 요구 사항

| 리소스 | 최소 요구 사항 | 권장 |

|---|---|---|

| CPU | 듀얼 코어 CPU | 쿼드 코어 CPU 또는 멀티 듀얼 코어 CPU |

| 메모리 | 데이터 웨어하우스가 설치되지 않았고 기존 프로세스가 메모리를 사용하지 않고 있는 경우 시스템 RAM이 4 GB 필요합니다. | 시스템 RAM 16 GB |

| 하드 디스크 | 로컬로 액세스할 수 있으며 쓰기 가능한 디스크 공간 25 GB |

로컬로 액세스할 수 있으며 쓰기 가능한 디스크 공간 50 GB

RHEV Manager History Database Size Calculator를 사용해서 해당 Manager 기록 데이터베이스 크기에 적절한 디스크 공간을 계산할 수 있습니다.

|

| 네트워크 인터페이스 | 최소 1 Gbps 대역폭의 네트워크 인터페이스 카드 (NIC) 한 개 | 최소 1 Gbps 대역폭의 네트워크 인터페이스 카드 (NIC) 한 개 |

2.1.2. 브라우저 요구 사항

- 계층 1: 완전하게 테스트되어 완전하게 지원되는 브라우저 및 운영 체제 조합입니다. Red Hat Engineering은 이 계층에서 브라우저 관련 문제를 해결하기 위해 최선을 다합니다.

- 계층 2: 부분적으로 테스트되어 작동될 수 있는 브라우저 및 운영 체제 조합입니다. 이 계층에는 제한된 지원이 제공됩니다. Red Hat Engineering은 이 계층에서 브라우저 관련 문제를 해결하려고 시도합니다.

- 계층 3: 테스트되지 않고 작동할 수 있는 브라우저 및 운영 체제 조합입니다. 최소 지원이 제공됩니다. Red Hat Engineering은 이 계층에서 브라우저 관련 사소한 문제만을 해결하려고 시도합니다.

표 2.2. 브라우저 요구 사항

| 지원 계층 | 운영 체제 제품군 | 브라우저 | 포털 액세스 |

|---|---|---|---|

| 계층 1 | Red Hat Enterprise Linux | Mozilla Firefox ESR (Extended Support Release) 버전 | 관리 포털 및 사용자 포털 |

| 계층 2 | Windows | Internet Explorer 10 이상 | 관리 포털 및 사용자 포털 |

| 모두 | 가장 최신 Google Chrome 또는 Mozilla Firefox 버전 | 관리 포털 및 사용자 포털 | |

| 계층 3 | 모두 | Google Chrome 또는 Mozilla Firefox 이전 버전 | 관리 포털 및 사용자 포털 |

| 모두 | 다른 브라우저 | 관리 포털 및 사용자 포털 |

2.1.3. 클라이언트 요구 사항

- 계층 1: 원격 뷰어가 완전히 테스트되고 지원되는 운영 체제입니다.

- 계층 2: 원격 뷰어가 부분적으로 테스트되고 작동될 수 있는 운영 체제입니다. 이 계층에는 제한된 지원이 제공됩니다. Red Hat Engineering은 이 계층에서 원격 뷰어 관련 문제를 해결합니다.

표 2.3. 클라이언트 운영 체제의 SPICE 지원

| 지원 계층 | 운영 체제 | SPICE 지원 |

|---|---|---|

| 계층 1 | Red Hat Enterprise Linux 7 | Red Hat Enterprise Linux 7.2 이상에서 완전 지원 |

| Microsoft Windows 7 | Microsoft Windows 7에서 완전 지원 | |

| 계층 2 | Microsoft Windows 8 | spice-vdagent가 게스트 운영 체제에서 실행되고 있는 경우 지원 |

| Microsoft Windows 10 | spice-vdagent가 게스트 운영 체제에서 실행되고 있는 경우 지원 |

2.1.4. 운영 체제 요구 사항

2.1.5. DNS 요구 사항

참고

/etc/hosts 파일에 항목을 추가하는 것으로 역방향 DNS 조회가 제공되지 않으므로 충분하지 않습니다.

2.2. 하이퍼바이저 요구 사항

2.2.1. CPU 요구 사항

표 2.4. 지원되는 하이퍼바이저 CPU 모델

| AMD | Intel | IBM |

|---|---|---|

| AMD Opteron G1 | Intel Conroe | IBM POWER8 |

| AMD Opteron G2 | Intel Penryn | |

| AMD Opteron G3 | Intel Nehalem | |

| AMD Opteron G4 | Intel Westmere | |

| AMD Opteron G5 | Intel Sandybridge | |

| Intel Haswell | ||

| Intel Skylake |

절차 2.1. 프로세서가 필요한 플래그 지원 여부 확인

- Red Hat Enterprise Linux 또는 Red Hat Virtualization Host 부팅 화면에서 아무 키나 누른 후 목록에서 Boot 또는 Boot with serial console 항목을 선택합니다.

- Tab을 클릭해서 선택된 옵션의 커널 매개 변수를 편집합니다.

- 목록 끝의 커널 매개 변수 뒤에 Space가 있는지 확인하고

rescue매개 변수를 추가합니다. - Enter를 눌러서 복구 모드로 부팅합니다.

- 표시되는 프롬프트에서 다음의 명령을 실행해서 사용자의 프로세서에 필요한 확장 기능이 있으며 활성화되어 있는지 확인합니다:

# grep -E 'svm|vmx' /proc/cpuinfo | grep nx

표시되는 내용이 있다면 프로세서에 하드웨어 가상화가 가능한 것입니다. 표시되는 내용이 없더라도 사용자의 프로세서가 하드웨어 가상화를 지원할 수도 있습니다. 일부의 경우 제조업체가 BIOS에서 가상화 확장을 비활성화하기도 합니다. 사용자가 이 경우에 해당된다고 생각된다면 해당 제조업체가 제공한 시스템 BIOS 및 마더보드 사용 설명서를 확인합니다.

2.2.2. 메모리 요구 사항

표 2.5. 메모리 요구 사항

| 최소 | 최대 |

|---|---|

| 2 GB의 RAM | 2 TB의 RAM |

2.2.3. 스토리지 요구 사항

표 2.6. Red Hat Virtualization Host 4.0 최소 스토리지 요구 사항

| / | /boot | /var | swap | 최소 요구 사항 합계 |

|---|---|---|---|---|

| 6 GB | 1 GB | 15 GB | 1 GB | 23 GB |

중요

2.2.4. PCI 장치 요구 사항

2.2.5. 장치 할당 시 하드웨어 고려 사항

- CPU가 IOMMU(예: VT-d 또는 AMD-Vi)를 지원해야 합니다. 기본적으로 IBM POWER8은 IOMMU를 지원합니다.

- 펌웨어가 IOMMU를 지원해야 합니다.

- CPU root 포트가 ACS 또는 ACS와 동급의 기능을 지원해야 합니다.

- PCIe 장치가 ACS 또는 ACS와 동급의 기능을 지원해야 합니다.

- 모든 PCIe 스위치, 그리고 PCIe 장치와 root 포트 간의 모든 브리지가 ACS를 지원하는 것이 권장됩니다. 예를 들어, 어떤 스위치가 ACS를 지원하지 않는 경우 해당 스위치의 모든 장치는 같은 IOMMU 그룹을 공유하기 때문에 동일한 가상 머신에만 할당될 수 있습니다.

- GPU 지원을 위해 Red Hat Enterprise Linux 7은 VGA 이외의 그래픽 장치로 NVIDIA K 시리즈 Quadro (2000 시리즈 이후 모델), GRID, 그리고 Tesla를 PCI 장치 할당하는 것을 지원합니다. 현재 표준 및 에뮬레이트된 VGA 인터페이스 중 하나에 추가해서 최대 2개의 GPU가 가상 머신에 연결될 수 있습니다. 사전 부팅 및 설치에는 에뮬레이트된 VGA가 사용되며 NVIDIA 그래픽 드라이버 실행 시 NVIDIA GPU가 대신 실행됩니다. NVIDIA Quadro 2000 및 Quadro K420 카드 모두 지원되지 않습니다.

lspci -v 명령을 사용해서 시스템에 이미 설치된 PCI 장치에 대한 설명을 출력할 수 있습니다.

2.3. 방화벽

2.3.1. Red Hat Virtualization Manager 방화벽 요구 사항

engine-setup 스크립트를 사용해서 방화벽을 자동으로 설정할 수 있지만 이것은 기존 방화벽 설정을 모두 덮어쓰기합니다.

engine-setup 명령을 사용해서 필요한 iptables 규칙 목록을 /usr/share/ovirt-engine/conf/iptables.example 파일에 저장합니다.

80 및 443 포트가 아닌 실제 선택된 해당 포트에 네트워크 트래픽을 허용합니다.

표 2.7. Red Hat Virtualization Manager 방화벽 요구 사항

| 포트 | 프로토콜 | 소스 | 대상 | 목적 |

|---|---|---|---|---|

| - | ICMP |

Red Hat Virtualization Host

Red Hat Enterprise Linux 호스트

|

Red Hat Virtualization Manager

| Red Hat Virtualization Manager 등록 시 온라인 여부를 확인하기 위해 가상화 호스트가 Manager에게 ICMP 핑(ping) 요청을 보냅니다. |

| 22 | TCP |

백엔드 설정과 소프트웨어 업그레이드를 포함하는 Manager 관리 시스템

|

Red Hat Virtualization Manager

|

보안 쉘 (SSH) 액세스

선택 사항

|

| 2222 | TCP |

가상 머신 직렬 콘솔에 액세스하는 클라이언트

|

Red Hat Virtualization Manager

|

가상 머신 직렬 콘솔 연결을 가능하게 하는 보안 쉘 (SSH) 액세스

|

| 80, 443 | TCP |

관리 포털 클라이언트

사용자 포털 클라이언트

Red Hat Virtualization Host

Red Hat Enterprise Linux 호스트

REST API 클라이언트

|

Red Hat Virtualization Manager

|

Manager에게 HTTP 및 HTTPS 액세스 제공

|

| 6100 | TCP |

관리 포털 클라이언트

사용자 포털 클라이언트

|

Red Hat Virtualization Manager

|

websocket 프록시가 Manager에서 실행중일 때 웹 기반 콘솔 클라이언트(

noVNC 및 spice-html5)에 websocket 프록시 액세스를 제공합니다. 그러나 websocket 프록시가 다른 호스트에서 실행중인 경우 해당 포트를 사용하지 않습니다.

|

| 7410 | UDP |

Red Hat Virtualization Host

Red Hat Enterprise Linux 호스트

|

Red Hat Virtualization Manager

| Manager가 Kdump 알림을 받을 수 있도록 반드시 열려 있어야 합니다. |

중요

NFSv4

- NFS용 TCP 포트

2049

NFSv3

- NFS용 TCP 및 UDP 포트

2049 - TCP 및 UDP 포트

111(rpcbind/sunrpc). MOUNTD_PORT="port"로 지정된 TCP 및 UDP 포트STATD_PORT="port"로 지정된 TCP 및 UDP 포트LOCKD_TCPPORT="port"로 지정된 TCP 포트LOCKD_UDPPORT="port"로 지정된 UDP 포트

MOUNTD_PORT, STATD_PORT, LOCKD_TCPPORT, 그리고 LOCKD_UDPPORT 포트는 모두 /etc/sysconfig/nfs 파일에 설정되어 있습니다.

2.3.2. 하이퍼바이저 방화벽 요구 사항

표 2.8. 가상화 호스트 방화벽 요구 사항

| 포트 | 프로토콜 | 소스 | 대상 | 목적 |

|---|---|---|---|---|

| 22 | TCP |

Red Hat Virtualization Manager

|

Red Hat Virtualization Host

Red Hat Enterprise Linux 호스트

|

보안 쉘 (SSH) 액세스

선택 사항

|

| 2223 | TCP |

Red Hat Virtualization Manager

|

Red Hat Virtualization Host

Red Hat Enterprise Linux 호스트

|

가상 머신 직렬 콘솔 연결을 가능하게 하는 보안 쉘 (SSH) 액세스

|

| 161 | UDP |

Red Hat Virtualization Host

Red Hat Enterprise Linux 호스트

|

Red Hat Virtualization Manager

|

단순 네트워크 관리 프로토콜(SNMP). 호스트에서 SNMP 트랩을 하나 이상의 외부 SNMP 관리자에게 보내는 경우에만 필요합니다.

선택 사항

|

| 5900 - 6923 | TCP |

관리 포털 클라이언트

사용자 포털 클라이언트

|

Red Hat Virtualization Host

Red Hat Enterprise Linux 호스트

|

VNC 및 SPICE를 통한 원격 게스트 콘솔 액세스. 해당 포트가 열려 있어야 클라이언트가 가상 머신에 액세스할 수 있습니다.

|

| 5989 | TCP, UDP |

Common Information Model Object Manager (CIMOM)

|

Red Hat Virtualization Host

Red Hat Enterprise Linux 호스트

|

Common Information Model Object Manager(CIMOM)가 호스트에 실행중인 가상 머신을 모니터링하는 데 사용됩니다. 사용자의 가상화 환경에서 CIMOM을 사용해서 가상 머신을 모니터링하는 경우에만 필요합니다.

선택 사항

|

| 9090 | TCP |

Red Hat Virtualization Manager

클라이언트 시스템

|

Red Hat Virtualization Host

Red Hat Enterprise Linux 호스트

|

Cockpit 사용자 인터페이스 액세스

선택 사항

|

| 16514 | TCP |

Red Hat Virtualization Host

Red Hat Enterprise Linux 호스트

|

Red Hat Virtualization Host

Red Hat Enterprise Linux 호스트

| libvirt을 사용한 가상 머신 마이그레이션

|

| 49152 - 49216 | TCP |

Red Hat Virtualization Host

Red Hat Enterprise Linux 호스트

|

Red Hat Virtualization Host

Red Hat Enterprise Linux 호스트

|

VDSM을 사용한 가상 머신 마이그레이션 및 차단. 해당 포트가 열려 있어야 가상 머신의 자동 및 수동 마이그레이션이 가능합니다.

|

| 54321 | TCP |

Red Hat Virtualization Manager

Red Hat Virtualization Host

Red Hat Enterprise Linux 호스트

|

Red Hat Virtualization Host

Red Hat Enterprise Linux 호스트

|

Manager와 다른 가상화 호스트와의 VDSM 통신

|

2.3.3. 디렉토리 서버 방화벽 요구 사항

표 2.9. 호스트 방화벽 요구 사항

| 포트 | 프로토콜 | 소스 | 대상 | 목적 |

|---|---|---|---|---|

| 88, 464 | TCP, UDP |

Red Hat Virtualization Manager

|

디렉토리 서버

| Kerberos 인증 |

| 389, 636 | TCP |

Red Hat Virtualization Manager

|

디렉토리 서버

| Lightweight Directory Access Protocol(LDAP) 및 SSL을 통한 LDAP. |

2.3.4. 데이터베이스 서버 방화벽 요구 사항

표 2.10. 호스트 방화벽 요구 사항

| 포트 | 프로토콜 | 소스 | 대상 | 목적 |

|---|---|---|---|---|

| 5432 | TCP, UDP |

Red Hat Virtualization Manager

|

PostgreSQL 데이터베이스 서버

| PostgreSQL 데이터베이스 연결에 사용할 기본 포트 |

II 부. Red Hat Virtualization Manager 설치

3장. Red Hat Virtualization Manager

3.1. 필요한 서브스크립션을 등록

- 사용자 시스템을 Content Delivery Network에 등록 시 사용자의 고객 포털 사용자 이름과 암호를 입력합니다:

# subscription-manager register

Red Hat Enterprise Linux Server및Red Hat Virtualization서브스크립션 풀을 찾아서 해당 풀 ID를 기록합니다.# subscription-manager list --available

- 이전 단계에서 기록한 풀 ID를 사용해서 시스템에 서브스크립션을 연결합니다:

# subscription-manager attach --pool=pool_id

참고

현재 연결된 서브스크립션을 확인하려면 다음의 명령을 실행합니다:# subscription-manager list --consumed

활성화된 모든 리포지터리 목록을 보려면 다음의 명령을 실행합니다:# yum repolist

- 기존의 모든 리포지터리를 비활성화합니다:

# subscription-manager repos --disable=*

- 필요한 리포지터리를 활성화합니다:

# subscription-manager repos --enable=rhel-7-server-rpms # subscription-manager repos --enable=rhel-7-server-supplementary-rpms # subscription-manager repos --enable=rhel-7-server-rhv-4.1-rpms # subscription-manager repos --enable=rhel-7-server-rhv-4-tools-rpms # subscription-manager repos --enable=jb-eap-7-for-rhel-7-server-rpms

3.2. Red Hat Virtualization Manager 패키지 설치

절차 3.1. Red Hat Virtualization Manager 패키지 설치

- Red Hat Virtualization Manager를 설치하는 시스템에 다음의 명령을 실행해서 모든 패키지가 업데이트되어 있는지 확인합니다:

# yum update

참고

커널 관련 패키지가 업데이트된 경우 시스템을 재부팅합니다. - 다음의 명령을 실행해서 rhevm 패키지와 관련 패키지를 모두 설치합니다.

# yum install rhevm

3.3. Red Hat Virtualization Manager 설정

engine-setup 명령을 사용해서 Red Hat Virtualization Manager를 설정해야 합니다. 이 명령은 사용자에게 일련의 질문을 하며, 사용자가 모든 질문에 대해 필요한 값을 입력하면 해당 설정을 적용하고 ovirt-engine 서비스를 시작합니다.

engine-setup 명령은 Manager 시스템에서 Manager 데이터베이스를 로컬로 생성하고 설정합니다. 다른 방법으로 사용자는 Manager가 원격 데이터베이스 또는 수동으로 설정된 로컬 데이터베이스를 사용하도록 설정할 수 있습니다. 하지만 engine-setup을 실행하기 전에 반드시 해당 데이터베이스를 먼저 설정해야 합니다. 원격 데이터베이스를 설정하는 방법은 부록 D. Red Hat Virtualization Manager에서 사용할 원격 PostgreSQL 데이터 베이스 준비를 참조하십시오. 로컬 데이터베이스를 수동으로 설정하는 방법은 부록 E. Red Hat Virtualization Manager에서 사용할 수동 설정 PostgreSQL 데이터 베이스 준비를 참조하십시오.

engine-setup 명령은 Manager에 websocket 프록시를 설정합니다. 하지만 보안과 성능을 이유로 사용자가 해당 프록시를 개별 호스트에 설정하는 것을 선택할 수 있습니다. 설정 방법은 부록 F. 다른 시스템에 대한 Websocket 프록시 설치를 참조하십시오.

참고

engine-setup 명령은 뚜렷이 구분되는 여러 설정 과정을 설명해 주며 각 과정은 사용자 입력을 필요로 하는 여러 가지 단계로 이루어져 있습니다. 권장 설정 기본값은 사각 괄호에 제시되어 있습니다. 특정 단계에서 제시된 값이 수용 가능하다면 Enter를 눌러서 해당 값을 허용합니다.

절차 3.2. Red Hat Virtualization Manager 설정

engine-setup명령을 실행해서 Red Hat Virtualization Manager 설정을 시작합니다:# engine-setup

- Enter를 클릭해서 Manager를 설정합니다:

Configure Engine on this host (Yes, No) [Yes]:

- 선택적으로

engine-setup을 허용하여 Manager에서 가상 디스크 이미지를 스토리지 도메인에 업로드할 수 있도록 이미지 I/O 프록시를 설정합니다. 자세한 내용은 관리 가이드에 있는 스토리지 도메인에 디스크 이미지 업로드를 참조하십시오.Configure Image I/O Proxy on this host? (Yes, No) [Yes]:

- 옵션으로

engine-setup을 사용해서 사용자들이 noVNC 또는 HTML 5 콘솔을 사용해서 가상 머신에 연결할 수 있게 해주는 websocket 프록시 서버를 설정합니다:Configure WebSocket Proxy on this machine? (Yes, No) [Yes]:

다른 시스템에서 websocket 프록시를 설정하려면No를 클릭하고 부록 F. 다른 시스템에 대한 Websocket 프록시 설치에 있는 설정 방법을 참조하십시오. - Manager 시스템에 데이터 웨어하우스를 설정할지 선택합니다.

Please note: Data Warehouse is required for the engine. If you choose to not configure it on this host, you have to configure it on a remote host, and then configure the engine on this host so that it can access the database of the remote Data Warehouse host. Configure Data Warehouse on this host (Yes, No) [Yes]:

별도의 시스템에 데이터 웨어하우스를 설정하려면No를 선택하고 데이터 웨어하우스 가이드에 있는 별도의 시스템에 데이터 웨어하우스 설치 및 설정에서 설치 및 설정 지침을 참조하십시오. - 옵션으로 명령행에서 가상 머신의 시리얼 콘솔에 액세스를 허용합니다.

Configure VM Console Proxy on this host (Yes, No) [Yes]:

이 기능을 사용하려면 클라이언트 시스템에 추가 설정을 해야 합니다. 가상 머신 관리 가이드에 있는 가상 머신에 대한 시리얼 콘솔 열기를 참조하십시오. - Enter를 눌러서 자동 인식된 호스트명을 받아들이거나 다른 호스트명을 입력하고 Enter를 누릅니다. 사용자가 가상 호스트를 사용중인 경우 자동 인식된 호스트명이 올바르지 않을 수 있습니다.

Host fully qualified DNS name of this server [autodetected host name]:

engine-setup명령을 사용해서 사용자의 방화벽 설정을 확인하고 TCP 포트 80과 443 등 Manager가 외부 통신에 사용하는 포트를 열도록 설정을 수정할 수 있습니다.engine-setup명령이 사용자의 방화벽 설정을 수정하도록 허용하지 않으면 사용자는 Manager가 사용하는 포트를 수동으로 열어야 합니다.Setup can automatically configure the firewall on this system. Note: automatic configuration of the firewall may overwrite current settings. Do you want Setup to configure the firewall? (Yes, No) [Yes]:

사용자가 방화벽의 자동 설정을 선택하고 현재 활성화되어 있는 방화벽 관리자가 없으면 사용자는 지원되는 옵션 목록에서 방화벽 관리자를 선택해야 합니다. 해당 방화벽 관리자 이름을 입력하고 Enter를 클릭합니다. 목록에 옵션이 하나 밖에 없는 경우에도 방법은 동일합니다.- 로컬 또는 원격 PostgreSQL 데이터베이스를 데이터 웨어하우스 데이터베이스로 사용하는 것을 선택합니다:

Where is the DWH database located? (Local, Remote) [Local]:

Local을 선택하는 경우engine-setup명령을 사용해서 사용자 데이터베이스를 자동으로 설정하거나 사전 설정된 로컬 데이터베이스에 연결할 수 있습니다:Setup can configure the local postgresql server automatically for the DWH to run. This may conflict with existing applications. Would you like Setup to automatically configure postgresql and create DWH database, or prefer to perform that manually? (Automatic, Manual) [Automatic]:

- Enter를 클릭해서

Automatic을 선택하는 경우 더 이상 아무런 조치를 할 필요가 없습니다. Manual을 선택하는 경우 수동으로 설정된 로컬 데이터베이스를 위해 다음 값을 입력합니다:DWH database secured connection (Yes, No) [No]: DWH database name [ovirt_engine_history]: DWH database user [ovirt_engine_history]: DWH database password:

참고

다음 단계에서 Manager 데이터베이스가 설정된 후engine-setup에 의해 해당 값이 요구됩니다.

Remote를 선택하는 경우 사전 설정된 원격 데이터베이스 호스트를 위해 다음 값을 입력합니다:DWH database host [localhost]: DWH database port [5432]: DWH database secured connection (Yes, No) [No]: DWH database name [ovirt_engine_history]: DWH database user [ovirt_engine_history]: DWH database password:

참고

다음 단계에서 Manager 데이터베이스가 설정된 후engine-setup에 의해 해당 값이 요구됩니다.

- 로컬 또는 원격 PostgreSQL 데이터베이스를 Manager 데이터베이스로 사용하는 것을 선택합니다:

Where is the Engine database located? (Local, Remote) [Local]:

Local을 선택하는 경우engine-setup명령을 사용해서 사용자 데이터베이스를 자동으로 설정하거나 사전 설정된 로컬 데이터베이스에 연결할 수 있습니다:Setup can configure the local postgresql server automatically for the engine to run. This may conflict with existing applications. Would you like Setup to automatically configure postgresql and create Engine database, or prefer to perform that manually? (Automatic, Manual) [Automatic]:

- Enter를 클릭해서

Automatic을 선택하는 경우 더 이상 아무런 조치를 할 필요가 없습니다. Manual을 선택하는 경우 수동으로 설정된 로컬 데이터베이스를 위해 다음 값을 입력합니다:Engine database secured connection (Yes, No) [No]: Engine database name [engine]: Engine database user [engine]: Engine database password:

Remote를 선택하는 경우 사전 설정된 원격 데이터베이스 호스트를 위해 다음 값을 입력합니다:Engine database host [localhost]: Engine database port [5432]: Engine database secured connection (Yes, No) [No]: Engine database name [engine]: Engine database user [engine]: Engine database password:

- Red Hat Virtualization Manager의 자동 생성된 관리 사용자의 암호를 설정합니다:

Engine admin password: Confirm engine admin password:

- Gluster, Virt, 또는 Both를 선택합니다:

Application mode (Both, Virt, Gluster) [Both]:

Both는 최대의 유연성을 제공합니다. 대부분의 경우Both를 선택합니다. Virt application mode는 사용자가 해당 환경에서 가상 머신을 실행할 수 있게 해줍니다. Gluster application mode는 사용자가 관리 포털에서만 GlusterFS를 관리할 수 있게 해줍니다. - 디스크가 삭제되었을 때 가상 디스크 블록을 삭제하는

wipe_after_delete플래그의 기본값을 설정합니다.Default SAN wipe after delete (Yes, No) [No]:

- Manager는 호스트와 안전하게 통신하기 위해 인증서를 사용합니다. 옵션으로 해당 인증서를 사용해서 Manager와 HTTPS 통신을 확보할 수도 있습니다. 해당 인증서의 조직 이름을 입력합니다:

Organization name for certificate [autodetected domain-based name]:

- 옵션으로

engine-setup명령을 사용해서 Manager의 랜딩 페이지를 Apache 웹 서버에서 제공하는 기본 페이지로 하는 것을 허용합니다:Setup can configure the default page of the web server to present the application home page. This may conflict with existing applications. Do you wish to set the application as the default web page of the server? (Yes, No) [Yes]:

- 기본값으로 Manager와의 외부 SSL (HTTPS) 통신은 이전에 호스트와 안전하게 통신하기 위해 생성된 자체 서명 인증서를 사용해서 확보합니다. 다른 방법으로 외부 HTTPS 연결을 위해 다른 인증서를 선택합니다. 이것은 Manager와 호스트간의 통신 방법에 영향을 주지 않습니다:

Setup can configure apache to use SSL using a certificate issued from the internal CA. Do you wish Setup to configure that, or prefer to perform that manually? (Automatic, Manual) [Automatic]:

- Manager에 ISO 스토리지 도메인으로 사용할 NFS 공유를 생성할지를 선택합니다. 로컬 ISO 도메인은 가상 머신의 초기 설정에 사용할 수 있는 다양한 이미지를 제공합니다.

Configure an NFS share on this server to be used as an ISO Domain? (Yes, No) [No]:

- 기본값 (

No)을 선택하면 더 이상의 조치가 필요하지 않습니다. Yes를 선택하면 추가 정보를 제공하여 ISO 도메인을 설정해야 합니다.- ISO 도메인 경로를 지정합니다:

Local ISO domain path [/var/lib/exports/iso]:

- ISO 도메인에 액세스가 필요한 네트워크 또는 호스트를 지정합니다:

Local ISO domain ACL: 10.1.2.0/255.255.255.0(rw) host01.example.com(rw) host02.example.com(rw)

위의 예시에서는 단일 /24 네트워크와 두 개의 특정 호스트에 대한 액세스가 허용됩니다. 자세한 포맷 옵션은exports(5)man 페이지를 참조하십시오. - ISO 도메인의 표시 이름을 지정합니다:

Local ISO domain name [ISO_DOMAIN]:

- 데이터 웨어하우스가 수집된 데이터를 얼마동안 유지할지 선택합니다:

참고

Manager 시스템에 데이터 웨어하우스를 설정하지 않도록 선택하는 경우 이 단계를 건너뜁니다.Please choose Data Warehouse sampling scale: (1) Basic (2) Full (1, 2)[1]:

Full을 선택하면 데이터 웨어하우스 가이드에 있는 데이터 스토리지 설정 기본값이 사용됩니다 (데이터 웨어하우스가 원격 호스트에 설치되는 경우 권장됨).Basic을 선택하면DWH_TABLES_KEEP_HOURLY값이720으로,DWH_TABLES_KEEP_DAILY값이0으로 감소하여 Manager 시스템의 부하가 완화됩니다(Manager와 데이터 웨어하우스를 동일한 시스템에 설치한 경우 권장됨). - 설치 설정 검토 후 Enter를 클릭해서 입력된 값에 동의하고 설치를 진행합니다:

Please confirm installation settings (OK, Cancel) [OK]:

- 사용자의 Red Hat Virtualization 환경을 디렉토리 서버에 연결하려면 예상하지 못한 계정 만료 문제를 피하기 위해 디렉토리 서버가 사용하는 시스템 클럭과 날짜 및 시간을 동기화합니다. 자세한 내용은 Red Hat Enterprise Linux 시스템 관리자 가이드에 있는 시스템 클럭과 원격 서버 동기화를 참조하십시오.

engine-setup 명령을 사용해서 사용자 환경에 액세스하는 자세한 방법을 표시합니다. 수동으로 방화벽을 설정하는 경우 engine-setup 명령을 실행하면 시작 시 선택된 옵션을 바탕으로 열어야 되는 포트의 사용자 정의 목록이 표시됩니다. 또한 engine-setup 명령을 사용해서 사용자 답변을 파일에 저장해서 동일한 값을 사용해서 Manager를 재설정하는 데 사용할 수 있고 Red Hat Virtualization Manager 설정 프로세스의 로그 파일 위치를 표시합니다.

admin@internal 사용자로 관리 포털에 연결하는 방법을 확인할 수 있습니다. 그 후 호스트 설정 및 스토리지 연결을 진행합니다.

3.4. 관리 포털 연결

- 웹 브라우저에서

https://your-manager-fqdn/ovirt-engine으로 이동합니다. 여기서 your-manager-fqdn 대신 사용자가 설치 시 제공한 정규화된 도메인 이름(FQDN)을 입력합니다.중요

관리 포털에 처음 연결하면 브라우저와 웹 서버 간 통신을 보호하는 데 사용되는 인증서를 신뢰하는지 묻는 메시지가 표시됩니다. 이 인증서를 허용해야 합니다. Firefox, Internet Explorer 또는 Google Chrome에서 인증 기관을 설치하는 지침을 참조하십시오.참고

대체 호스트 이름 또는 IP 주소를 사용하여 관리 포털에 액세스할 수 있습니다. 이를 위해서는/etc/ovirt-engine/engine.conf.d/에 설정 파일을 추가해야 합니다. 예를 들면 다음과 같습니다.# vi /etc/ovirt-engine/engine.conf.d/99-custom-sso-setup.conf SSO_ALTERNATE_ENGINE_FQDNS="alias1.example.com alias2.example.com"

대체 호스트 이름 목록은 공백으로 구분해야 합니다. Manager의 IP 주소를 목록에 추가할 수도 있지만 DNS 확인 가능 호스트 이름 대신 IP 주소를 사용하는 것은 좋지 않습니다. - 관리 포털을 클릭합니다.

- 사용자 이름 및 암호를 입력합니다. 최초 로그인하는 경우 사용자 이름을

admin으로 입력하고 설치 시 사용자가 지정한 암호를 입력합니다. - 도메인 목록에서 인증 대상 도메인을 선택합니다. 내부

admin사용자 이름으로 로그인시internal도메인을 선택합니다. - 로그인을 클릭합니다.

- 관리 포털은 다양한 언어로 볼 수 있습니다. 웹 브라우저의 로케일 설정에 따라 기본 선택 항목이 선택됩니다. 기본 설정 언어 이외의 언어로 관리 포털을 보려면 시작 페이지의 드롭다운 목록에서 원하는 언어를 선택합니다.

4장. Red Hat Virtualization Manager 관련 작업

4.1. Red Hat Virtualization Manager 제거

engine-cleanup 명령을 실행합니다.

참고

/var/lib/ovirt-engine/backups/에 저장되며 파일 이름에 각각 날짜와 engine- 및 engine-pki-가 포함됩니다.

절차 4.1. Red Hat Virtualization Manager 제거

- Red Hat Virtualization Manager가 설치된 시스템에 다음의 명령을 실행합니다:

# engine-cleanup

- 모든 Red Hat Virtualization Manager 구성요소 제거 여부를 확인합니다:

Yes입력 후 Enter를 눌러서 모든 구성 요소를 제거합니다:Do you want to remove all components? (Yes, No) [Yes]:

No입력 후 Enter를 눌러서 제거할 구성 요소를 선택합니다. 각 구성 요소의 유지/제거 여부를 개별적으로 선택할 수 있습니다:Do you want to remove Engine database content? All data will be lost (Yes, No) [No]: Do you want to remove PKI keys? (Yes, No) [No]: Do you want to remove PKI configuration? (Yes, No) [No]: Do you want to remove Apache SSL configuration? (Yes, No) [No]:

- 이 단계에서 Red Hat Virtualization Manager 제거를 취소할 수 있습니다. 제거를 진행하는 경우

ovirt-engine서비스가 중지되며 사용자 환경 설정은 사용자가 선택한 옵션에 따라 제거됩니다.During execution engine service will be stopped (OK, Cancel) [OK]: ovirt-engine is about to be removed, data will be lost (OK, Cancel) [Cancel]:OK

- Red Hat Virtualization 패키지를 제거합니다:

# yum remove rhevm* vdsm-bootstrap

4.2. Red Hat Virtualization Manager 오프라인 설치를 위한 로컬 리포지터리 설정

- 컨텐츠 전송 네트워크(CDN)에 액세스 가능한 시스템에 Red Hat Enterprise Linux 7 서버를 설치합니다. 해당 시스템은 필요한 모든 패키지를 다운로드하고 사용자의 오프라인 시스템에 배포합니다.

중요

이 절차에 사용되는 시스템에 디스크 여유 공간이 많이 있는지 확인합니다. 다수의 패키지가 다운로드되며 디스크 여유 공간이 50GB 필요합니다. - 사용자 시스템을 Content Delivery Network에 등록 시 사용자의 고객 포털 사용자 이름과 암호를 입력합니다:

# subscription-manager register

- 시스템에 필요한 모든 서브스크립션을 등록합니다:

Red Hat Enterprise Linux Server및Red Hat Virtualization서브스크립션 풀을 찾아서 해당 풀 ID를 기록합니다.# subscription-manager list --available

- 이전 단계에서 기록한 풀 ID를 사용해서 시스템에 서브스크립션을 연결합니다:

# subscription-manager attach --pool=pool_id

- 기존의 모든 리포지터리를 비활성화합니다:

# subscription-manager repos --disable=*

- 필요한 리포지터리를 활성화합니다:

# subscription-manager repos --enable=rhel-7-server-rpms # subscription-manager repos --enable=rhel-7-server-supplementary-rpms # subscription-manager repos --enable=rhel-7-server-rhv-4.1-rpms # subscription-manager repos --enable=rhel-7-server-rhv-4-tools-rpms # subscription-manager repos --enable=jb-eap-7-for-rhel-7-server-rpms

- 현재 설치된 모든 패키지가 업데이트되어 있는지 확인합니다:

# yum update

참고

커널 관련 패키지가 업데이트된 경우 시스템을 재부팅합니다.

- 인터넷 연결이 없는 서버는 File Transfer Protocol(FTP)을 사용해서 다른 시스템에 있는 소프트웨어 리포지터리에 액세스할 수 있습니다. FTP 리포지터리를 생성하려면 vsftpd를 설치 및 설정합니다:

- vsftpd 패키지를 설치합니다:

# yum install vsftpd

vsftpd서비스를 시작하고 부팅 시 서비스가 시작되는지 확인합니다:# systemctl start vsftpd.service # systemctl enable vsftpd.service

/var/ftp/pub/디렉토리에 하위 디렉토리를 생성합니다. 다운로드한 패키지를 모두 이 디렉토리에서 찾을 수 있습니다.# mkdir /var/ftp/pub/rhevrepo

- 설정된 모든 소프트웨어 리포지터리에서 패키지를

rhevrepo디렉토리로 다운로드합니다. 여기에는 시스템이 구독되어 있는 모든 CDN(Content Delivery Network) 서브스크립션 풀 리포지터리와 로컬로 설정된 리포지터리가 포함됩니다.# reposync -l -p /var/ftp/pub/rhevrepo

해당 명령을 사용해서 다수의 패키지가 다운로드되며 완료되는 데 시간이 오래 걸립니다.-l옵션을 사용하면 yum 플러그인이 지원됩니다. - createrepo 패키지를 설치합니다:

# yum install createrepo

/var/ftp/pub/rhevrepo아래에서 패키지가 다운로드된 각 하위 디렉토리에 대해 리포지터리 메타데이터를 생성합니다.# for DIR in `find /var/ftp/pub/rhevrepo -maxdepth 1 -mindepth 1 -type d`; do createrepo $DIR; done;

- 리포지터리 파일을 생성하고 Manager를 설치할 오프라인 시스템의

/etc/yum.repos.d/디렉토리에 해당 파일을 복사합니다.수동으로 또는 스크립트를 사용해서 설정 파일을 생성합니다. 리포지터리를 호스팅하는 시스템에 다음의 스크립트를 실행하는데,baseurl에 있는 ADDRESS 대신 리포지터리를 호스팅하는 시스템의 IP 주소 또는 정규화된 도메인 이름(FQDN)을 입력합니다:#!/bin/sh REPOFILE="/etc/yum.repos.d/rhev.repo" for DIR in `find /var/ftp/pub/rhevrepo -maxdepth 1 -mindepth 1 -type d`; do echo -e "[`basename $DIR`]" > $REPOFILE echo -e "name=`basename $DIR`" >> $REPOFILE echo -e "baseurl=ftp://ADDRESS/pub/rhevrepo/`basename $DIR`" >> $REPOFILE echo -e "enabled=1" >> $REPOFILE echo -e "gpgcheck=0" >> $REPOFILE echo -e "\n" >> $REPOFILE done; - 오프라인 시스템에 Manager 패키지를 설치합니다. 설치 방법은 3.2절. “Red Hat Virtualization Manager 패키지 설치”를 참조하십시오. 패키지는 CDN 대신에 로컬 리포지터리에서 설치됩니다.

- Manager를 설정합니다. 초기 설정 방법은 3.3절. “Red Hat Virtualization Manager 설정”을 참조하십시오.

- 다음 부분에서 호스트, 스토리지, 그리고 가상 머신 설정을 진행합니다.

III 부. 호스트 설치

5장. 호스트 소개

중요

getenforce를 실행하십시오. Red Hat에서 Red Hat Virtualization 환경을 지원하려면 모든 하이퍼바이저 및 Manager에서 SELinux를 강제 모드로 설정해야 합니다.

표 5.1. 호스트

| 호스트 유형 | 다른 이름 | 설명 |

|---|---|---|

|

Red Hat Virtualization Host

|

RHVH, 씬 호스트 (thin host)

|

Red Hat Enterprise Linux 기반의 최소 운영 체제. 고객 포털에서 ISO 파일로 배포되며 여기에는 시스템이 호스트 역할을 하는 데 필요한 패키지만 포함되어 있습니다.

|

|

Red Hat Enterprise Linux Host

|

RHEL 기반 하이퍼바이저, 씩 호스트 (thick host)

|

적절한 채널에 구독되어 있는 Red Hat Enterprise Linux 호스트는 호스트로 사용될 수 있습니다.

|

5.1. 호스트 호환성

6장. Red Hat Virtualization Host

6.1. Red Hat Virtualization Host 설치

- 고객 포털에서 RHVH ISO 이미지를 다운로드합니다.

- RHVH ISO 이미지를 USB, CD 또는 DVD에 작성합니다.

- RHVH 최소 운영 체제를 설치합니다.

절차 6.1. Red Hat Virtualization Host 설치

- 고객 포털에서 RHVH ISO 이미지를 다운로드합니다.

- 고객 포털(https://access.redhat.com)에 로그인합니다.

- 메뉴 표시줄에서 다운로드를 클릭합니다.

- Red Hat Virtualization을 클릭하고 위로 스크롤한 다음 최신 버전 다운로드를 클릭하여 제품 다운로드 페이지에 액세스합니다.

- 해당 하이퍼바이저 이미지를 선택하고 지금 다운로드를 클릭합니다.

- 부팅 가능 미디어 장치를 만듭니다. 자세한 내용은 Red Hat Enterprise Linux 설치 가이드에 있는 미디어 만들기를 참조하십시오.

- 준비된 설치 미디어를 사용하여 RHVH를 설치할 시스템을 시작합니다.

- 부트 메뉴에서 설치 옵션을 선택한 후 Enter를 누릅니다.

참고

Tab 키를 눌러서 커널 매개 변수를 편집할 수도 있습니다. 커널 매개 변수는 공백으로 구분해야 하며, Enter 키를 눌러 지정된 커널 매개 변수를 사용하여 시스템을 부팅할 수 있습니다. Esc 키를 누르면 커널 매개 변수 변경 사항을 모두 취소하고 부트 메뉴로 돌아갑니다. - 언어를 선택한 후 계속 을 클릭합니다.

- 날짜 및 시간 화면에서 시간대를 선택하고 완료를 클릭합니다.

- 키보드 화면에서 키보드 레이아웃을 선택하고 완료를 클릭합니다.

- 설치 대상 화면에서 RHVH를 설치할 장치를 선택합니다. 선택적으로 암호화를 활성화합니다. 완료를 클릭합니다.

중요

자동으로 파티셔닝 설정 옵션을 사용하는 것이 좋습니다.참고

RHVH를 다시 설치할 때 로컬 스토리지 도메인을 보존하는 방법에 대한 자세한 내용은 https://access.redhat.com/solutions/2804081을 참조하십시오. - 네트워크 및 호스트 이름 화면에서 네트워크를 선택하고 설정...을 클릭하여 연결 상세 정보를 설정합니다. 호스트 이름 필드에 호스트 이름을 입력하고 완료를 클릭합니다.

- 옵션에서 언어 지원, 보안 정책 및 Kdump를 설정합니다. 설치 요약 화면의 각 섹션에 대한 자세한 내용은 Red Hat Enterprise Linux 7 설치 가이드에 있는 Anaconda를 사용하여 설치를 참조하십시오.

- 설치 시작을 클릭합니다.

- RHVH가 설치되는 동안 root 암호를 설정하고 원할 경우 추가 사용자를 만듭니다.

주의

로컬 보안의 취약점을 악용할 수 있으므로 RHVH에 신뢰할 수 없는 사용자를 만들지 않는 것이 좋습니다. - 재부팅을 클릭하여 설치를 완료합니다.

참고

RHVH가 다시 시작되면imgbase-motd.service에서 호스트에 대한 상태 점검을 수행하고 로그인 시 명령행에 결과를 표시합니다.imgbase status: OK또는imgbase status: DEGRADED메시지는 상태를 나타냅니다. 자세한 내용을 보려면imgbase check를 실행하십시오. 이 서비스는 기본적으로 활성화되어 있습니다. - 설치가 완료되면 https://HostFQDNorIP:9090에 있는 Cockpit 사용자 인터페이스에 로그인하여 호스트를 컨텐츠 전송 네트워크 (Content Delivery Network)에 등록합니다. 도구 > 서브스크립션 > 시스템 등록을 클릭하여 고객 포털 사용자 이름과 암호를 입력합니다. 시스템이 자동으로 Red Hat Virtualization Host 서브스크립션에 등록됩니다.

- Terminal을 클릭하고 추후 Red Hat Virtualization Host 업데이트를 허용하도록

Red Hat Virtualization Host 7리포지터리를 활성화합니다.# subscription-manager repos --enable=rhel-7-server-rhvh-4-rpms

6.2. 고급 설치

6.2.1. 사용자 정의 파티셔닝

- 수동 파티셔닝 창에서 LVM 씬 프로비저닝 옵션을 선택해야 합니다.

- root (

/) 디렉토리가 씬 프로비저닝된 논리 볼륨에 있어야 합니다. - root (

/) 디렉토리가 6GB 이상이어야 합니다. /var디렉토리가 별도의 볼륨 또는 디스크에 있어야 합니다.- XFS 또는 Ext4 파일 시스템만 지원됩니다.

6.2.2. Red Hat Virtualization Host 배포 자동화

절차 6.2. PXE 및 킥스타트를 사용한 배포 자동화

- 고객 포털에서 RHVH ISO 이미지를 다운로드합니다.

- 고객 포털(https://access.redhat.com)에 로그인합니다.

- 메뉴 표시줄에서 다운로드를 클릭합니다.

- Red Hat Virtualization을 클릭하고 위로 스크롤한 다음 최신 버전 다운로드를 클릭하여 제품 다운로드 페이지에 액세스합니다.

- 해당 하이퍼바이저 이미지를 선택하고 지금 다운로드를 클릭합니다.

- 설치 소스 - 네트워크에 있는 지침을 사용하여 네트워크에서 RHVH ISO 이미지를 사용할 수 있도록 설정합니다.

- 네트워크 설치 준비에 있는 지침을 사용하여 PXE 서버를 설정합니다.PXE 서버에서 RHVH를 부팅하는 데에는 다음과 같은 요구 사항이 적용됩니다.

- RHVH 부팅 이미지를

tftp/root 디렉토리로 복사해야 합니다.# cp URL/to/RHVH-ISO/images/pxeboot/{vmlinuz,initrd.img} /var/lib/tftpboot/pxelinux/ - 부트 로더 설정 파일에 RHVH 부팅 이미지를 지정하는 RHVH 레이블이 포함되어 있어야 합니다.

KERNEL URL/to/vmlinuz APPEND initrd=URL/to/initrd.img inst.stage2=URL/to/RHVH-ISO

- 킥스타트 설치에 있는 지침을 사용하여 킥스타트 파일을 만들고 네트워크에서 사용할 수 있도록 설정합니다.RHVH 킥스타트 파일에는 다음과 같은 제한 사항이 적용됩니다.

- RHVH에는

%packages섹션이 필요하지 않습니다. 대신liveimg옵션을 사용하여 RHVH ISO 이미지에서squashfs.img파일을 지정합니다.liveimg --url=URL/to/squashfs.img

autopart명령을 사용하는 것이 좋습니다. 씬 프로비저닝을 사용해야 합니다.autopart --type=thinp

설치에 수동 파티셔닝이 필요한 경우에는 다음과 같은 제한 사항이 적용됩니다.- root(

/) 디렉토리가 씬 프로비저닝된 논리 볼륨에 있어야 합니다. /var디렉토리가 별도의 볼륨에 있어야 합니다./boot디렉토리가 별도의 파티션에 있어야 합니다.

nodectl init명령을 호출하는%post섹션이 필요합니다.%post nodectl init %end

설치 프로세스를 완전히 자동화하려면 이 킥스타트 파일을 PXE 서버의 부트 로더 설정 파일에 추가하면 됩니다.APPEND행에inst.ks=를 추가하여 킥스타트 위치를 지정합니다.APPEND initrd=URL/to/initrd.img inst.stage2=URL/to/RHVH-ISO inst.ks=URL/to/RHVH-ks.cfg

예 6.1. Red Hat Virtualization Host 킥스타트 파일

다음은 Red Hat Virtualization Host를 배포하는 데 사용되는 킥스타트 파일의 예입니다. 필요에 따라 추가 명령 및 옵션을 포함할 수 있습니다.liveimg --url=http://1.2.3.4/path/to/squashfs.img clearpart --all autopart --type=thinp rootpw --plaintext ovirt timezone --utc America/Phoenix zerombr text reboot %post --erroronfail nodectl init %end

- PXE를 사용하여 네트워크에서 AMD64 및 Intel 64 Systems에 설치 시작에 있는 지침을 사용하여 RHVH를 설치합니다.

7장. Red Hat Enterprise Linux 호스트

7.1. Red Hat Enterprise Linux 호스트 설치

Red Hat Enterprise Linux Server 및 Red Hat Virtualization 서브스크립션이 활성화되어 있는 물리적인 서버에 Red Hat Enterprise Linux를 기본적으로 설치하는 것을 바탕으로 합니다. 자세한 설치 방법은 Red Hat Enterprise Linux 7 설치 가이드를 참조하시기 바랍니다.

중요

중요

7.2. 필요한 서브스크립션을 등록

Red Hat Enterprise Linux Server 및 Red Hat Virtualization 서브스크립션을 호스트에 연결합니다.

절차 7.1. Subscription Manager를 사용하여 필요한 서브스크립션에 등록

- 사용자 시스템을 Content Delivery Network에 등록 시 사용자의 고객 포털 사용자 이름 및 암호를 입력합니다:

# subscription-manager register

Red Hat Enterprise Linux Server및Red Hat Virtualization서브스크립션 풀을 찾아서 해당 풀 ID를 기록합니다.# subscription-manager list --available

- 이전 단계에서 기록한 풀 ID를 사용해서 시스템에 서브스크립션을 연결합니다:

# subscription-manager attach --pool=poolid

참고

현재 연결된 서브스크립션을 확인하려면 다음의 명령을 실행합니다:# subscription-manager list --consumed

활성화된 모든 리포지터리 목록을 보려면 다음의 명령을 실행합니다:# yum repolist

- 기존의 모든 리포지터리를 비활성화합니다:

# subscription-manager repos --disable=*

- 필요한 리포지터리를 활성화합니다:

# subscription-manager repos --enable=rhel-7-server-rpms # subscription-manager repos --enable=rhel-7-server-rhv-4-mgmt-agent-rpms

IBM POWER8 하드웨어에 Red Hat Enterprise Linux 7 little endian 호스트를 설치하려면 다음 리포지터리를 활성화합니다.# subscription-manager repos --enable=rhel-7-server-rhv-4-mgmt-agent-for-power-le-rpms # subscription-manager repos --enable=rhel-7-for-power-le-rpms

- 현재 설치된 모든 패키지가 업데이트되어 있는지 확인합니다:

# yum update

참고

커널 관련 패키지가 업데이트된 경우 시스템을 재부팅합니다.

8장. Red Hat Virtualization Manager에 대한 Host 추가

절차 8.1. Red Hat Virtualization Manager에 대한 Host 추가

- 관리 포털에서 호스트 리소스 탭을 클릭합니다.

- 새로 만들기를 클릭합니다.

- 드롭 다운 목록을 사용하여 새 호스트의 데이터 센터 및 호스트 클러스터를 선택합니다.

- 새 호스트의 이름과 주소를 입력합니다. SSH 포트 란에 표준 SSH 포트인 포트 22가 자동으로 채워집니다.

- Manager가 호스트에 액세스 시 인증방법을 선택합니다.

- 암호 인증을 사용하려면 root 사용자의 암호를 입력합니다.

- 또는, SSH 공개 키 란에 있는 키를 공개 키 인증을 사용할 호스트의

/root/.ssh/authorized_keys에 복사합니다.

- 고급 호스트 설정을 보려면 고급 매개 변수 버튼을 클릭합니다.

- 옵션으로 자동 방화벽 설정을 비활성화합니다.

- 옵션으로 보안을 강화하기 위해 호스트 SSH 지문을 추가합니다. 이를 수동으로 추가하거나 자동으로 가져오기할 수 있습니다.

- 옵션으로 호스트에 지원되는 전원 관리 카드가 있는 경우 전원 관리를 설정합니다. 전원 관리 설정에 대한 자세한 내용은 관리 가이드에 있는 호스트 전원 관리 설정을 참조하십시오.

- OK를 클릭합니다.

Installing 상태로 호스트 목록에 표시되고 상세 정보 창에서 설치 진행 상태를 확인할 수 있습니다. 잠시 후 호스트 상태가 Up으로 변경됩니다.

IV 부. 스토리지 연결

9장. 스토리지

9.1. 스토리지 소개

- 데이터 도메인: 데이터 도메인은 데이터 센터에서 모든 가상 머신과 템플릿의 가상 하드 디스크와 OVF 파일을 수용하며, 여러 데이터 센터에서 공유될 수 없습니다. 여러 유형의 데이터 도메인 (iSCSI, NFS, FC, POSIX, Gluster)이 로컬 도메인이 아닌 공유 도메인인 경우 해당 도메인을 모두 동일한 데이터 센터에 추가할 수 있습니다.

중요

ISO 도메인과 내보내기 도메인을 연결할 수 있기 위해서는 먼저Up상태인 호스트가 하나 있어야 하며 데이터 센터에 데이터 도메인을 연결해야 합니다. - ISO 도메인: ISO 도메인에는 가상 머신의 운영 체제 및 애플리케이션을 설치 및 시작하는데 사용하는 ISO 파일(또는 논리 CD)이 저장되어 있으며, 여러 데이터 센터에서 공유될 수 있습니다. ISO 도메인에서의 데이터 센터에서는 물리적 미디어가 필요하지 않습니다. ISO 도메인은 NFS만을 기반으로 할 수 있습니다. 하나의 ISO 도메인만 데이터 센터에 추가할 수 있습니다.

- 내보내기 도메인: 내보내기 도메인은 데이터 센터와 Red Hat Virtualization 환경 간의 이미지를 복사 및 이동하는 데 사용되는 임시 스토리지 리포지터리입니다. 내보내기 도메인은 가상 머신을 백업하는 데 사용할 수 있습니다. 내보내기 도메인은 데이터 센터 간에 이동할 수 있지만 한 번에 하나의 데이터 센터에서만 활성화할 수 있습니다. 내보내기 도메인은 NFS 만을 기반으로 할 수 있습니다. 하나의 내보내기 도메인만 데이터 센터에 추가할 수 있습니다.

9.2. FCP 스토리지 추가

절차 9.1. FCP 스토리지 추가

- 스토리지 리소스 탭을 클릭하면 모든 스토리지 도메인 목록이 표시됩니다.

- 새로운 도메인을 클릭하면 새로운 도메인 창이 열립니다.

- 스토리지 도메인의 이름을 입력합니다.

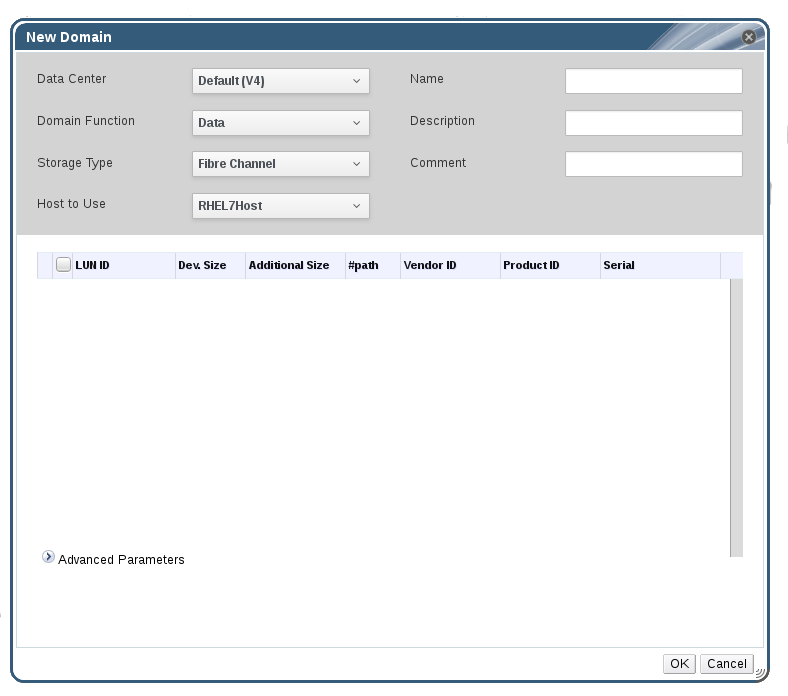

그림 9.1. FCP 스토리지 추가

- 데이터 센터 드롭 다운 메뉴에서 FCP 데이터 센터를 선택합니다.적절한 FCP 데이터 센터가 없을 경우

(none)을 선택합니다. - 드롭 다운 메뉴를 사용하여 도메인 기능 및 스토리지 유형을 선택합니다. 선택한 데이터 센터와 호환되지 않는 스토리지 도메인 유형은 사용할 수 없습니다.

- 사용 호스트 란에서 활성 호스트를 선택합니다. 데이터 센터에 있는 첫 번째 데이터 도메인이 아닐 경우 데이터 센터의 SPM 호스트를 선택해야 합니다.

중요

스토리지 도메인에서의 모든 통신은 Red Hat Virtualization Manager에서 직접 이루어 지는 것이 아니라 선택한 호스트를 통해 이루어집니다. 시스템에 최소한 하나의 활성 호스트가 존재해야 하며 선택한 데이터 센터에 연결되어 있어야 합니다. 모든 호스트는 스토리지 도메인을 설정하기 전 스토리지 장치에 액세스할 수 있어야 합니다. - 스토리지 유형으로 Data / Fibre Channel이 선택되어 있을 때 새로운 도메인 창에는 사용하지 않는 LUN이 있는 알려진 대상이 자동으로 표시됩니다. LUN ID 확인란을 선택하여 사용 가능한 모든 LUN을 선택합니다.

- 옵션으로 고급 매개 변수를 설정할 수 있습니다.

- 고급 매개 변수를 클릭합니다.

- 디스크 공간 부족 경고 표시 필드에 백분율 값을 입력합니다. 스토리지 도메인에서 사용 가능한 여유 공간이 해당 백분율 값 아래로 내려가면 사용자에게 경고 메세지가 표시되고 기록됩니다.

- 심각히 부족한 디스크 공간의 동작 차단 필드에 GB 단위로 값을 입력합니다. 스토리지 도메인에서 사용 가능한 여유 공간이 해당 값 아래로 내려가면 사용자에게 오류 메세지가 표시되고 기록되며 공간을 소비하는 모든 새로운 동작은 일시적이라도 모두 차단됩니다.

- 삭제 후 초기화 확인란을 선택하여 삭제 후 초기화 옵션을 활성화합니다. 이 옵션은 도메인 생성 후 편집할 수 있지만 이러한 경우 이미 존재하는 디스크의 삭제 후 초기화 속성은 변경되지 않습니다.

- 삭제 후 폐기 확인란을 선택하여 삭제 후 폐기 옵션을 활성화합니다. 이 옵션은 도메인 생성 후 편집할 수 있으며 스토리지 도메인을 차단하는 데에만 사용할 수 있습니다.

- OK를 클릭하여 스토리지 도메인을 생성하고 창을 닫습니다.

Locked 상태로 되어 있습니다. 사용 준비되면 이는 자동으로 데이터 센터에 연결됩니다.

부록 A. 로컬 ISO 도메인 권한 변경

절차 A.1. 로컬 ISO 도메인 권한 변경

- Manager 시스템에 로그인합니다.

/etc/exports파일을 편집하고 호스트 또는 호스트가 속한 서브넷을 액세스 제어 목록에 추가합니다:/var/lib/exports/iso 10.1.2.0/255.255.255.0(rw) host01.example.com(rw) host02.example.com(rw)

위의 예시에서는 단일 /24 네트워크와 두 개의 특정 호스트에 대한 읽기 및 쓰기 액세스가 허용됩니다./var/lib/exports/iso는 해당 ISO 도메인의 기본 파일 경로입니다. 자세한 포맷 설정 옵션은exports(5)man 페이지를 참조하시기 바랍니다.- 변경 사항을 적용합니다:

# exportfs -ra

engine-setup 실행 후 /etc/exports 파일을 수동으로 편집한 후 engine-cleanup을 실행하면 변경 사항이 해제되지 않습니다.

부록 B. 로컬 ISO 도메인의 데이터 센터 연결

절차 B.1. 로컬 ISO 도메인의 데이터 센터 연결

- 관리 포털에서 데이터 센터 리소스 탭을 클릭하여 해당하는 데이터 센터를 선택합니다.

- 상세 정보 창에서 스토리지 탭을 선택하여 데이터 센터에 이미 연결된 스토리지 도메인 목록을 나열합니다.

- ISO 연결을 클릭하여 ISO 라이브러리 연결 창을 엽니다.

- 로컬 ISO 도메인의 라디오 버튼을 클릭합니다.

- OK를 클릭합니다.

부록 C. Red Hat Gluster Storage 노드에 Gluster 프로세스 활성화

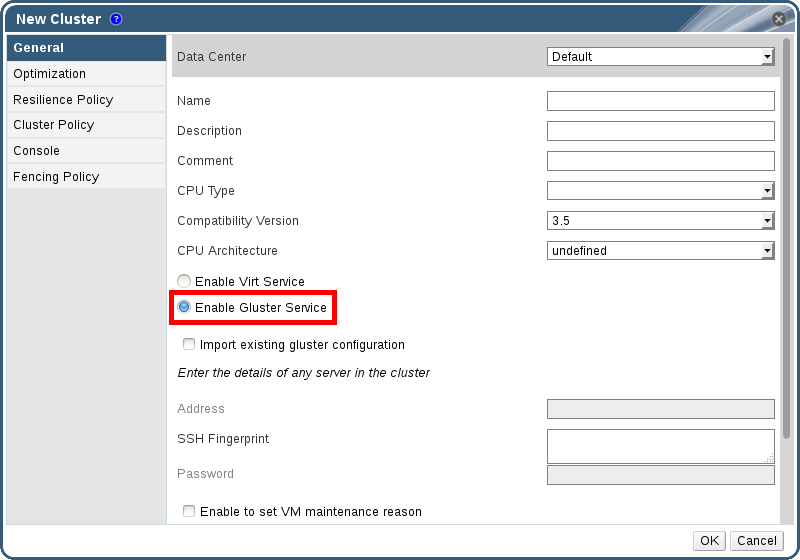

- 탐색 창에서 클러스터 탭을 선택합니다.

- 새로 만들기를 선택합니다.

- "Gluster 서비스 활성화" 라디오 버튼을 클릭합니다. 필요한 주소, SSH 지문, 암호 등을 입력합니다. 주소와 암호란은 기존의 Gluster 설정을 가져옴 확인란이 선택되었을 때에만 입력 가능합니다.

그림 C.1. "Gluster 서비스 활성화" 라디오 버튼 클릭하기

- OK를 클릭합니다.

부록 D. Red Hat Virtualization Manager에서 사용할 원격 PostgreSQL 데이터 베이스 준비

engine-setup 설정 스크립트를 사용해서 Manager 데이터베이스를 Manager 시스템에 로컬로 생성하고 설정합니다. 자동 데이터베이스 설정 방법은 3.3절. “Red Hat Virtualization Manager 설정”을 참조하십시오. Manager 시스템에 사용자 지정 값을 가진 Manager 데이터베이스를 설정하는 방법은 부록 E. Red Hat Virtualization Manager에서 사용할 수동 설정 PostgreSQL 데이터 베이스 준비를 참조하십시오.

engine-setup 시 데이터베이스 인증 정보를 입력해야 하므로 Manager 설정 전에 우선 해당 데이터베이스를 설정합니다.

참고

engine-setup 및 engine-backup --mode=restore 명령은 시스템 로캘(locale)이 다른 경우에도 en_US.UTF8 로캘에서만 시스템 오류 메시지를 지원합니다.

postgresql.conf 파일의 로캘 설정이 en_US.UTF8로 설정되어야 합니다.

중요

절차 D.1. Red Hat Virtualization Manager에서 사용할 원격 PostgreSQL 데이터 베이스 준비

- PostgreSQL 서버 패키지를 설치합니다:

# yum install postgresql-server

- PostgreSQL 데이터베이스를 초기화하고

postgresql서비스를 시작합니다. 해당 서비스가 부팅 시 시작되는지 확인합니다:# su -l postgres -c "/usr/bin/initdb --locale=en_US.UTF8 --auth='ident' --pgdata=/var/lib/pgsql/data/" # systemctl start postgresql.service # systemctl enable postgresql.service

postgres사용자로 psql 명령행 인터페이스에 연결합니다:# su - postgres $ psql

- Manager가 데이터베이스에서 읽기/쓰기 시 사용할 사용자를 생성합니다. Manager의 기본 사용자 이름은

engine입니다:postgres=# create role user_name with login encrypted password 'password';

- Red Hat Virtualization 환경에 대한 데이터를 저장할 데이터베이스를 생성합니다. Manager의 기본 데이터베이스 이름은

engine입니다:postgres=# create database database_name owner user_name template template0 encoding 'UTF8' lc_collate 'en_US.UTF-8' lc_ctype 'en_US.UTF-8';

- 새로운 데이터베이스에 연결하고

plpgsql언어를 추가합니다:postgres=# \c database_name database_name=# CREATE LANGUAGE plpgsql;

- md5 클라이언트 인증을 활성화하여 원격으로 데이터베이스에 액세스할 수 있습니다.

/var/lib/pgsql/data/pg_hba.conf파일을 편집하고 다음 행을 파일 아래에 있는local로 시작하는 행 바로 아래에 추가합니다. 여기서 X.X.X.X는 Manager의 IP 주소로 변경합니다:host database_name user_name X.X.X.X/32 md5

- 데이터베이스에 TCP/IP 연결을 허용합니다.

/var/lib/pgsql/data/postgresql.conf파일을 편집하고 다음 행을 추가합니다:listen_addresses='*'

위의 예시에서는 모든 인터페이스에서의 연결을 수신하도록postgresql서비스를 설정하고 있습니다. IP 주소로 인터페이스를 지정할 수 있습니다. - PostgreSQL 데이터베이스 연결에 사용할 기본 포트를 열고 업데이트된 방화벽 규칙을 저장합니다:

# yum install iptables-services # iptables -I INPUT 5 -p tcp --dport 5432 -j ACCEPT # service iptables save

postgresql서비스를 다시 시작합니다:# systemctl restart postgresql.service

부록 E. Red Hat Virtualization Manager에서 사용할 수동 설정 PostgreSQL 데이터 베이스 준비

engine-setup 설정 스크립트를 사용해서 Manager 데이터베이스를 Manager 시스템에 로컬로 생성하고 설정합니다. 자동 데이터베이스 설정 방법은 3.3절. “Red Hat Virtualization Manager 설정”을 참조하십시오. Manager가 설치된 시스템과 다른 시스템에 Manager 데이터베이스를 설정하는 방법은 부록 D. Red Hat Virtualization Manager에서 사용할 원격 PostgreSQL 데이터 베이스 준비를 참조하십시오.

engine-setup 시 데이터베이스 인증 정보를 입력해야 하므로 Manager 설정 전에 먼저 해당 데이터베이스를 설정합니다. 데이터베이스 설정을 위해 우선 Manager 시스템에 rhevm 패키지를 설치해야 합니다. postgresql-server 패키지는 관련 패키지로 설치됩니다.

참고

engine-setup 및 engine-backup --mode=restore 명령은 시스템 로캘(locale)이 다른 경우에도 en_US.UTF8 로캘에서만 시스템 오류 메시지를 지원합니다.

postgresql.conf 파일의 로캘 설정이 en_US.UTF8로 설정되어야 합니다.

중요

절차 E.1. Red Hat Virtualization Manager에서 사용할 수동 설정 PostgreSQL 데이터 베이스 준비

- PostgreSQL 데이터베이스를 초기화하고

postgresql서비스를 시작합니다. 해당 서비스가 부팅 시 시작되는지 확인합니다:# su -l postgres -c "/usr/bin/initdb --locale=en_US.UTF8 --auth='ident' --pgdata=/var/lib/pgsql/data/" # systemctl start postgresql.service # systemctl enable postgresql.service

postgres사용자로 psql 명령행 인터페이스에 연결합니다.# su - postgres $ psql

- Manager가 데이터베이스에서 읽기/쓰기 시 사용할 사용자를 생성합니다. Manager의 기본 사용자 이름은

engine입니다:postgres=# create role user_name with login encrypted password 'password';

- Red Hat Virtualization 환경에 대한 데이터를 저장할 데이터베이스를 생성합니다. Manager의 기본 데이터베이스 이름은

engine입니다:postgres=# create database database_name owner user_name template template0 encoding 'UTF8' lc_collate 'en_US.UTF-8' lc_ctype 'en_US.UTF-8';

- 새로운 데이터베이스에 연결하고

plpgsql언어를 추가합니다:postgres=# \c database_name database_name=# CREATE LANGUAGE plpgsql;

- md5 클라이언트 인증을 활성화하여 원격으로 데이터베이스에 액세스할 수 있습니다.

/var/lib/pgsql/data/pg_hba.conf파일을 편집하고 다음 행을 파일 아래에 있는local로 시작하는 행 바로 아래에 추가합니다:host [database name] [user name] 0.0.0.0/0 md5 host [database name] [user name] ::0/0 md5

postgresql서비스를 다시 시작합니다:# systemctl restart postgresql.service

부록 F. 다른 시스템에 대한 Websocket 프록시 설치

참고

절차 F.1. 다른 시스템에 대한 Websocket 프록시 설치 및 설정

- websocket 프록시를 설치합니다:

# yum install ovirt-engine-websocket-proxy

engine-setup명령을 실행해서 websocket 프록시를 설정합니다.# engine-setup

참고

rhevm 패키지도 설치된 경우 해당 호스트에 대한 engine 설정 여부를 물으면No를 선택합니다.- Enter를 클릭해서

engine-setup이 시스템에 websocket 프록시 서버를 설치하는 것을 허용합니다.Configure WebSocket Proxy on this machine? (Yes, No) [Yes]:

- Enter를 눌러서 자동 인식된 호스트명을 받아들이거나 다른 호스트명을 입력하고 Enter를 누릅니다. 사용자가 가상 호스트를 사용중인 경우 자동 인식된 호스트명이 올바르지 않을 수 있습니다:

Host fully qualified DNS name of this server [host.example.com]:

- Enter를 클릭해서

engine-setup이 외부 통신에 필요한 방화벽을 설치하고 포트를 여는 것을 허용합니다.engine-setup명령이 사용자의 방화벽 설정을 수정하도록 허용하지 않으면 사용자는 필요한 포트를 수동으로 열어야 합니다.Setup can automatically configure the firewall on this system. Note: automatic configuration of the firewall may overwrite current settings. Do you want Setup to configure the firewall? (Yes, No) [Yes]:

- Manager 시스템의 정규화된 DNS 이름을 입력하고 Enter 키를 누릅니다.

Host fully qualified DNS name of the engine server []: engine_host.example.com

- Enter를 클릭해서

engine-setup이 Manager 시스템에서 작업하는 것을 허용하거나 또는 2를 눌러서 사용자가 수동으로 작업합니다.Setup will need to do some actions on the remote engine server. Either automatically, using ssh as root to access it, or you will be prompted to manually perform each such action. Please choose one of the following: 1 - Access remote engine server using ssh as root 2 - Perform each action manually, use files to copy content around (1, 2) [1]:

- Enter를 눌러서 기본 SSH 포트 번호를 수락하거나 Manager 시스템의 포트 번호를 입력합니다.

ssh port on remote engine server [22]:

- Manager 시스템의 root 로그인 암호를 입력하고 Enter를 누릅니다.

root password on remote engine server engine_host.example.com:

- iptables 규칙이 현재 설정과 다른 경우 해당 규칙 검토 여부를 선택합니다.

Generated iptables rules are different from current ones. Do you want to review them? (Yes, No) [No]:

- Enter를 눌러서 설정을 확인합니다.

--== CONFIGURATION PREVIEW ==-- Firewall manager : iptables Update Firewall : True Host FQDN : host.example.com Configure WebSocket Proxy : True Engine Host FQDN : engine_host.example.com Please confirm installation settings (OK, Cancel) [OK]:설정된 websocket 프록시를 사용하도록 Manager 시스템을 설정하는 방법이 표시됩니다.Manual actions are required on the engine host in order to enroll certs for this host and configure the engine about it. Please execute this command on the engine host: engine-config -s WebSocketProxy=host.example.com:6100 and than restart the engine service to make it effective - Manager 시스템에 로그인하고 위에 설명된 설정을 실행합니다.

# engine-config -s WebSocketProxy=host.example.com:6100 # systemctl restart ovirt-engine.service

부록 G. PCI 통과(passthrough)를 위한 호스트 설정

전제 조건:

- 호스트 하드웨어가 PCI 장치 통과 및 할당 요구 사항을 충족하는지 확인합니다. 자세한 정보는 2.2.4절. “PCI 장치 요구 사항”을 참조하십시오.

절차 G.1. PCI 통과(passthrough)를 위한 호스트 설정

- BIOS에서 가상화 확장 및 IOMMU 확장 기능을 활성화합니다. 자세한 내용은 Red Hat Enterprise Linux 가상화 및 관리 가이드에 있는 BIOS에서 Intel VT-x 및 AMD-V 가상화 하드웨어 확장 활성화를 참조하십시오.

- 호스트를 Manager에 추가할 때 호스트 장치 통과 & SR-IOV 확인란을 선택하거나

grub설정 파일을 수동으로 편집하여 커널에서 IOMMU 플래그를 활성화합니다.- 관리 포털에서 IOMMU 플래그를 활성화하려면 관리 가이드에 있는 Red Hat Virtualization Manager에 호스트 추가 및 커널 설정을 참조하십시오.

grub설정 파일을 수동으로 편집하려면 절차 G.2. “IOMMU 수동 활성화”를 참조하십시오.

- GPU 통과(Passthrough)를 위해서는 호스트 및 게스트 시스템 모두에 추가적인 설정 단계를 실행해야 합니다. 자세한 내용은 관리 가이드에 있는 GPU 통과에 필요한 호스트 및 게스트 시스템 준비를 참조하십시오.

절차 G.2. IOMMU 수동 활성화

- GRUB 설정 파일을 편집해서 IOMMU를 활성화합니다.

참고

IBM POWER8 하드웨어를 사용하는 경우 기본값으로 IOMMU가 활성화되어 있으므로 이 단계를 건너뜁니다.- Intel의 경우 시스템을 부팅한 후

grub설정 파일의GRUB_CMDLINE_LINUX행 끝에intel_iommu=on를 덧붙입니다.# vi /etc/default/grub ... GRUB_CMDLINE_LINUX="nofb splash=quiet console=tty0 ... intel_iommu=on ...

- AMD의 경우 시스템을 부팅한 후

grub설정 파일의GRUB_CMDLINE_LINUX행 끝에amd_iommu=on를 덧붙입니다.# vi /etc/default/grub ... GRUB_CMDLINE_LINUX="nofb splash=quiet console=tty0 ... amd_iommu=on ...

참고

intel_iommu=on또는amd_iommu=on이 작동한다면intel_iommu=pt또는amd_iommu=pt로 바꿔 봅니다.pt옵션을 사용해서 통과(passthrough)에 사용되는 장치만 IOMMU가 활성화하고 더 나은 호스트 성능을 제공합니다. 하지만 모든 하드웨어에서 이 옵션이 지원되지는 않을 수 있습니다. 사용자 호스트에pt옵션이 작동하지 않으면 이전 옵션으로 돌아갑니다.하드웨어가 인터럽트 리매핑(interrupt remapping)을 지원하지 않아서 통과가 실패하는 경우 가상 머신이 신뢰할 수 있다면allow_unsafe_interrupts옵션을 활성화할 수도 있습니다.allow_unsafe_interrupts옵션을 활성화하면 잠재적으로 호스트가 가상 머신으로부터 MSI 공격에 노출될 수 있어서 기본값으로 활성화되어 있지 않습니다. 해당 옵션을 활성화하는 방법은 다음과 같습니다:# vi /etc/modprobe.d options vfio_iommu_type1 allow_unsafe_interrupts=1

- 변경 사항을 적용하려면

grub.cfg파일을 새로고침하고 호스트를 재부팅합니다:# grub2-mkconfig -o /boot/grub2/grub.cfg

# reboot