Red Hat Training

A Red Hat training course is available for Red Hat Virtualization

기술 자료

Red Hat Virtualization 환경의 기술 아키텍처

초록

1장. 소개

1.1. Red Hat Virtualization Manager

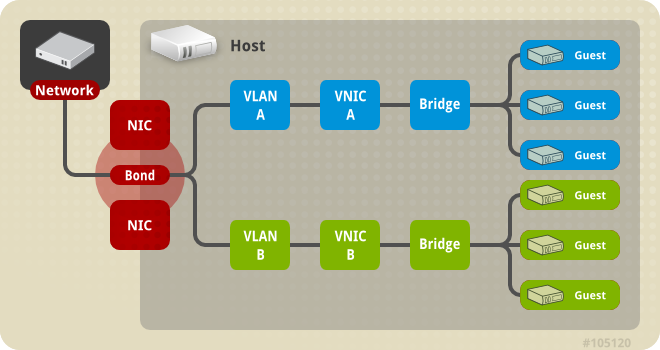

그림 1.1. Red Hat Virtualization Manager 아키텍처

1.2. Red Hat Virtualization Host

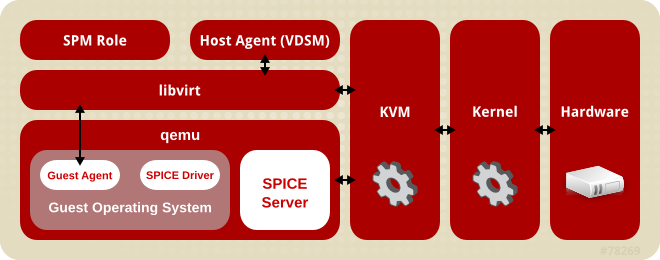

그림 1.2. 호스트 아키텍처

- KVM(커널 기반 가상 머신)

- KVM(커널 기반 가상 시스템)은 Intel VT 또는 AMD-V 하드웨어 확장을 사용하여 완전한 가상화를 제공하는 로드 가능한 커널 모듈입니다. KVM 자체는 커널 공간에서 실행되지만 게스트는 사용자 공간에서 개별 QEMU 프로세스로 실행됩니다. KVM을 사용하면 가상 머신에서 물리적 하드웨어를 사용할 수 있습니다.

- QEMU

- QEMU는 전체 시스템 에뮬레이션을 제공하는 데 사용되는 멀티 플랫폼 에뮬레이터입니다. QEMU는 하나 이상의 프로세서와 같은 전체 시스템을 에뮬레이션합니다. QEMU는 다른 운영 체제를 시작하거나 시스템 코드를 디버깅하는 데 사용할 수 있습니다. KVM 및 적절한 가상화 확장 기능이 있는 프로세서와 함께 작동하는 QEMU는 완전한 하드웨어 지원 가상화를 제공합니다.

- Red Hat Virtualization Manager 호스트 에이전트, VDSM

- Red Hat Virtualization에서

VDSM은 가상 머신 및 스토리지에 대한 작업을 시작합니다. 또한 호스트 간 통신을 용이하게 합니다. VDSM은 메모리, 스토리지 및 네트워킹과 같은 호스트 리소스를 모니터링합니다. 또한 VDSM은 가상 머신 생성, 통계 누적 및 로그 수집과 같은 작업을 관리합니다. VDSM 인스턴스는 각 호스트에서 실행되며, 재구성 가능한 포트54321을 사용하여 Red Hat Virtualization Manager에서 관리 명령을 받습니다.VDSM-REG

VDSM은VDSM-REG를 사용하여 각 호스트를 Red Hat Virtualization Manager에 등록합니다.VDSM-REG는 포트80또는 포트443을 사용하여 자체 및 호스트에 대한 정보를 제공합니다. libvirt- libvirt를 사용하면 가상 시스템 및 관련 가상 장치를 쉽게 관리할 수 있습니다. Red Hat Virtualization Manager가 가상 머신 라이프사이클 명령(시작, 중지, 재부팅)을 시작하면 VDSM에서 관련 호스트 머신에서 libvirt를 호출하여 실행합니다.

- 스토리지 풀 관리자(Storage Pool Manager)

- 스토리지 풀 관리자(SPM)는 데이터 센터에서 하나의 호스트에 할당된 역할입니다. DestinationRule 호스트는 데이터 센터의 모든 스토리지 도메인 구조 메타데이터 변경을 수행할 수 있는 유일한 권한을 갖습니다. 여기에는 가상 디스크 이미지, 스냅샷 및 템플릿 생성, 삭제 및 조작이 포함됩니다. 또한 SAN( Storage Area Network)에서 스파스 블록 장치에 대한 스토리지 할당이 포함됩니다. ECDHE의 역할은 데이터 센터의 모든 호스트로 마이그레이션할 수 있습니다. 결과적으로 데이터 센터의 모든 호스트는 데이터 센터에 정의된 모든 스토리지 도메인에 액세스할 수 있어야 합니다.Red Hat Virtualization Manager를 통해 항상 사용할 수 있는지 확인합니다. 스토리지 연결 오류가 발생하는 경우 Manager는 NSX 역할을 다른 호스트에 다시 할당합니다.

- 게스트 운영 체제

- Red Hat Virtualization 환경에서 가상 머신을 수정하지 않고도 게스트 운영 체제를 설치할 수 있습니다. 게스트 운영 체제 및 게스트의 모든 애플리케이션은 가상화 환경을 인식하지 못하고 정상적으로 실행됩니다.Red Hat은 가상화된 장치에 더 빠르고 효율적으로 액세스할 수 있는 향상된 장치 드라이버를 제공합니다. 또한 관리 콘솔에 향상된 게스트 정보를 제공하는 Red Hat Virtualization 게스트 에이전트를 게스트에 설치할 수도 있습니다.

1.3. 관리자 액세스 인터페이스

- 사용자 포털

- 데스크탑 가상화는 사용자가 개인용 컴퓨터의 데스크탑 환경과 유사한 데스크탑 환경을 제공합니다. 사용자 포털은 가상 데스크탑 인프라 를 사용자에게 제공하기 위한 것입니다. 사용자는 웹 브라우저를 통해 사용자 포털에 액세스하여 할당된 가상 데스크탑을 표시하고 액세스합니다. 사용자 포털에서 사용자가 사용할 수 있는 작업은 시스템 관리자가 설정합니다. 표준 사용자는 시스템 관리자가 할당한 데스크탑을 시작, 중지 및 사용할 수 있습니다. 고급 사용자는 일부 관리 작업을 수행할 수 있습니다. 두 유형의 사용자 모두 동일한 URL에서 사용자 포털에 액세스하고 로그인 시 권한 수준에 적합한 옵션이 제공됩니다.

표준 사용자 액세스

표준 사용자는 가상 데스크탑의 전원을 켜거나 끄고 사용자 포털을 통해 연결할 수 있습니다. 가상 머신에 대한 직접 연결은 SPICE(Lightweight Computing Environment) 또는 VNC(Virtual Network Computing) 클라이언트를 위한 간단한 프로토콜로 원활하게 연결됩니다. 두 프로토콜 모두 사용자에게 로컬로 설치된 데스크탑 환경과 유사한 환경을 제공합니다. 관리자는 가상 머신을 생성할 때 가상 머신에 연결하는 데 사용되는 프로토콜을 지정합니다.

사용자 포털 및 지원되는 브라우저 및 클라이언트에서 사용할 수 있는 작업에 대한 자세한 내용은 사용자 포털 소개 에서 확인할 수 있습니다.Power User Access

Red Hat Virtualization 사용자 포털은 가상 리소스를 생성, 사용 및 모니터링할 수 있는 그래픽 사용자 인터페이스를 사용자에게 제공합니다. 시스템 관리자는 고급 사용자에게 액세스 권한을 부여하여 일부 관리 작업을 위임할 수 있습니다. 표준 사용자가 수행할 수 있는 작업 외에도 고급 사용자는 다음을 수행할 수 있습니다.

- 가상 머신을 생성, 편집 및 제거합니다.

- 가상 디스크 및 네트워크 인터페이스를 관리합니다.

- 사용자 권한을 가상 머신에 할당합니다.

- 템플릿을 생성하고 사용하여 가상 머신을 신속하게 배포합니다.

- 리소스 사용량 및 높은 심각도 이벤트를 모니터링합니다.

- 스냅샷을 생성하고 사용하여 가상 머신을 이전 상태로 복원합니다.

고급 사용자는 가상 시스템 관리 작업을 위임할 수 있습니다. 환경 관리자에게 데이터 센터 및 클러스터 수준 관리 작업이 저장됩니다.

- 관리 포털

- 관리 포털은 Red Hat Virtualization Manager 서버의 그래픽 관리 인터페이스입니다. 관리자는 웹 브라우저에서 를 사용하여 가상화된 환경의 모든 요소를 모니터링, 생성 및 유지 관리할 수 있습니다. 관리 포털에서 수행할 수 있는 작업은 다음과 같습니다.

- 가상 인프라(네트워크, 스토리지 도메인) 생성 및 관리.

- 호스트 설치 및 관리

- 논리 엔티티(데이터 센터, 클러스터) 생성 및 관리.

- 가상 머신 생성 및 관리.

- Red Hat Virtualization 사용자 및 권한 관리.

관리 포털은 JavaScript를 사용하여 표시됩니다.관리 포털 기능은 Red Hat Virtualization 관리 가이드에서 자세히 설명합니다. 관리 포털에서 지원하는 브라우저 및 플랫폼에 대한 정보는 Red Hat Virtualization 설치 가이드에서 참조하십시오. - REST(Representational State Transfer) API

- Red Hat Virtualization REST API는 Red Hat Virtualization 환경의 순환 및 제어를 위한 소프트웨어 인터페이스를 제공합니다. REST API는 HTTP 작업을 지원하는 모든 프로그래밍 언어에서 사용할 수 있습니다.REST API 개발자 및 관리자는 다음을 수행할 수 있습니다.

- 엔터프라이즈 IT 시스템과 통합.

- 타사 가상화 소프트웨어와 통합.

- 자동화된 유지보수 및 오류 검사 작업을 수행합니다.

- 스크립트를 사용하여 Red Hat Virtualization 환경에서 반복적인 작업을 자동화합니다.

API 사양 및 사용 예제는 Red Hat Virtualization REST API 가이드를 참조하십시오.

1.4. 관리자를 지원하는 구성 요소

- Red Hat JBoss Enterprise Application Platform

- Red Hat JBoss Enterprise Application Platform은 Java 애플리케이션 서버입니다. 플랫폼 간 Java 애플리케이션을 효율적으로 개발하고 제공할 수 있는 프레임워크를 제공합니다. Red Hat Virtualization Manager는 Red Hat JBoss Enterprise Application Platform을 사용하여 제공됩니다.중요Red Hat Virtualization Manager와 함께 제공되는 Red Hat JBoss Enterprise Application Platform 버전은 다른 애플리케이션에 사용할 수 없습니다. Red Hat Virtualization Manager 서비스를 제공하기 위한 특정 목적으로 사용자 지정되었습니다. 추가 목적으로 Manager에 포함된 Red Hat JBoss Enterprise Application Platform을 사용하면 Red Hat Virtualization 환경을 서비스하는 데 부정적인 영향을 미칩니다.

- 보고서 및 데이터 수집

- Red Hat Virtualization Manager에는 호스트, 가상 머신 및 스토리지에 대한 모니터링 데이터를 수집하는 데이터 확보가 포함되어 있습니다. 여러 사전 정의 보고서를 사용할 수 있습니다. 고객은 환경을 분석하고 SQL을 지원하는 쿼리 도구를 사용하여 보고서를 생성할 수 있습니다.Red Hat Virtualization Manager 설치 프로세스는 두 개의 데이터베이스를 생성합니다. 이러한 데이터베이스는 설치 중에 선택된 Postgres 인스턴스에서 생성됩니다.

- engine 데이터베이스는 Red Hat Virtualization Manager에서 사용하는 기본 데이터 저장소입니다. 상태, 구성 및 성능과 같은 가상화 환경에 대한 정보는 이 데이터베이스에 저장됩니다.

- ovirt_engine_history 데이터베이스에는 engine 작동 데이터베이스에서 시간이 지남에 따라 충돌하는 구성 정보 및 통계 메트릭이 포함되어 있습니다. engine 데이터베이스의 구성 데이터는 1분마다 검사되며 변경 사항은 ovirt_engine_history 데이터베이스에 복제됩니다. 데이터베이스에 대한 변경 사항을 추적하면 데이터베이스의 개체에 대한 정보가 제공됩니다. 이를 통해 Red Hat Virtualization 환경의 성능을 분석 및 개선하고 어려움을 해결할 수 있습니다.ovirt_engine_history 데이터베이스를 기반으로 보고서를 생성하는 방법에 대한 자세한 내용은 Red Hat Virtualization DataECDHE 가이드의 기록 데이터베이스 를 참조하십시오.

중요ovirt_engine_history 데이터베이스의 데이터 복제는 RHEVM 기록 서비스인 ovirt-engine-dwhd에서 수행합니다. - 디렉터리 서비스

- 디렉터리 서비스는 사용자 및 조직 정보에 대한 중앙 집중식 네트워크 기반 스토리지를 제공합니다. 저장된 정보 유형에는 애플리케이션 설정, 사용자 프로필, 그룹 데이터, 정책, 액세스 제어가 포함됩니다. Red Hat Virtualization Manager는 Active Directory, IdM(Identity Management), OpenLDAP 및 Red Hat Directory Server 9를 지원합니다. 관리 목적으로만 로컬, 내부 도메인도 있습니다. 이 내부 도메인에는 admin 사용자라는 하나의 사용자만 있습니다.

1.5. 스토리지

- 데이터 스토리지 도메인

- 데이터 도메인은 환경에서 실행되는 모든 가상 시스템의 가상 하드 디스크 이미지를 유지합니다. 가상 머신의 템플릿과 스냅샷도 데이터 도메인에 저장됩니다. 데이터 도메인은 데이터 센터 간에 공유할 수 없습니다.

- 스토리지 도메인 내보내기

- 내보내기 도메인은 데이터 센터와 Red Hat Virtualization 환경 간에 이미지를 복사하고 이동하는 데 사용되는 임시 스토리지 리포지토리입니다. 내보내기 도메인을 사용하여 가상 머신 및 템플릿을 백업할 수 있습니다. 내보내기 도메인은 데이터 센터 간에 이동할 수 있지만 한 번에 하나의 데이터 센터에서만 활성화할 수 있습니다.

- ISO 스토리지 도메인

- ISO 도메인은 가상 시스템의 운영 체제 및 애플리케이션을 설치하는 데 사용되는 논리적 CD-ROM인 ISO 파일을 저장합니다. 물리적 CD-ROM 또는 DVD 라이브러리를 대체하는 논리 엔티티로서 ISO 도메인은 물리적 미디어에 대한 데이터 센터의 필요성을 제거합니다. ISO 도메인은 다른 데이터 센터 간에 공유할 수 있습니다.

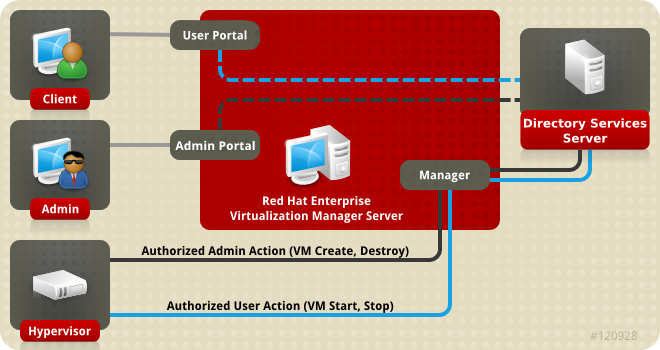

1.6. 네트워크

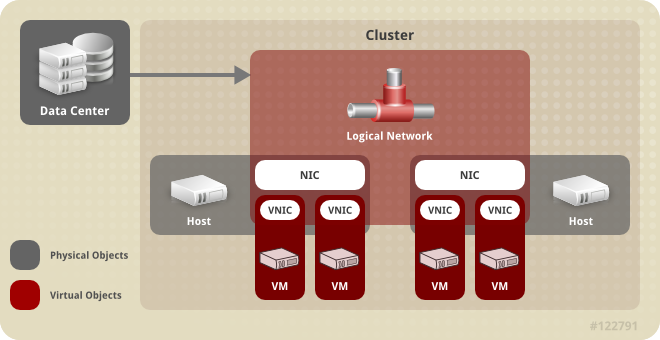

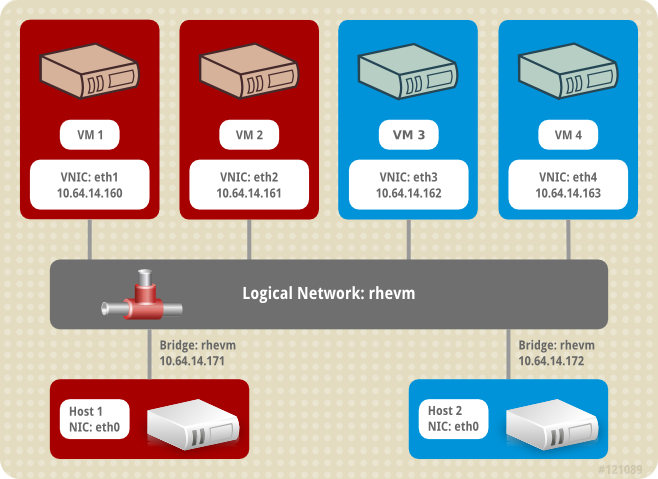

그림 1.3. 네트워크 아키텍처

- 네트워킹 인프라 계층

- Red Hat Virtualization 네트워크 아키텍처는 몇 가지 일반적인 하드웨어 및 소프트웨어 장치를 사용합니다.

- NIC (네트워크 인터페이스 컨트롤러 )는 호스트를 네트워크에 연결하는 물리적 네트워크 인터페이스 장치입니다.

- V NIC(가상 NIC)는 호스트의 물리적 NIC를 사용하여 작동하는 논리 NIC입니다. 가상 머신에 대한 네트워크 연결을 제공합니다.

- 본딩은 여러 NIC를 단일 인터페이스에 바인딩합니다.

- 브리지 는 패킷 전환 네트워크의 패킷 전달 기술입니다. 가상 머신 논리적 네트워크의 기반이 됩니다.

- 논리 네트워크

- 논리 네트워크를 사용하면 환경 요구 사항에 따라 네트워크 트래픽을 분리할 수 있습니다. 논리적 네트워크의 유형은 다음과 같습니다.

- 가상 머신 네트워크 트래픽을 전송하는 논리적 네트워크

- 가상 시스템 네트워크 트래픽을 전송하지 않는 논리 네트워크

- 선택적 논리적 네트워크

- 및 필수 네트워크

모든 논리 네트워크는 필수 또는 선택 사항일 수 있습니다.가상 시스템 네트워크 트래픽을 전송하는 논리적 네트워크는 호스트 수준에서 소프트웨어 브릿지 장치로 구현됩니다. 기본적으로 Red Hat Virtualization Manager 설치 중에 하나의 논리 네트워크가 정의되어 있습니다(ovirtmgmt관리 네트워크).관리자가 추가할 수 있는 기타 논리적 네트워크는 전용 스토리지 논리 네트워크와 전용 디스플레이 논리 네트워크입니다. 가상 시스템 트래픽을 전송하지 않는 논리 네트워크에는 호스트에 연결된 브릿지 장치가 없습니다. 호스트 네트워크 인터페이스와 직접 연결됩니다.Red Hat Virtualization은 마이그레이션 관련 네트워크 트래픽으로부터 관리 관련 네트워크 트래픽을 분리합니다. 따라서 실시간 마이그레이션에 전용 네트워크를 사용할 수 있으며(ovirtmgmt) 관리 네트워크(ovirtmgmt)가 마이그레이션 중에 하이퍼바이저에 대한 연결이 손실되지 않습니다. - 서로 다른 계층의 논리적 네트워크에 대한 설명

- 논리 네트워크는 가상화 환경의 계층마다 다른 영향을 미칩니다.

데이터 센터 계층

논리적 네트워크는 데이터 센터 수준에서 정의됩니다. 각 데이터 센터에는 기본적으로

ovirtmgmt관리 네트워크가 있습니다. 추가 논리 네트워크는 선택 사항이지만 권장됩니다. VM 네트워크로 지정 및 사용자 지정 MTU는 데이터 센터 수준에서 설정할 수 있습니다. 데이터 센터에 정의된 논리 네트워크도 논리 네트워크를 사용하는 클러스터에 추가해야 합니다.클러스터 계층

논리적 네트워크는 데이터 센터에서 사용할 수 있도록 설정되며 이를 사용할 클러스터에 추가해야 합니다. 각 클러스터는 기본적으로 관리 네트워크에 연결되어 있습니다. 선택적으로 클러스터의 상위 데이터 센터에 정의된 클러스터 논리 네트워크에 추가할 수 있습니다. 필수 논리적 네트워크가 클러스터에 추가된 경우 클러스터의 각 호스트에 대해 구현해야 합니다. 선택적 논리적 네트워크는 필요에 따라 호스트에 추가할 수 있습니다.

호스트 계층

가상 시스템 논리 네트워크는 클러스터의 각 호스트에 대해 지정된 네트워크 인터페이스와 연결된 소프트웨어 브릿지 장치로 구현됩니다. 비가상 시스템 논리 네트워크에는 연결된 브릿지가 없으며 호스트 네트워크 인터페이스와 직접 연결됩니다. 각 호스트에는 Red Hat Virtualization 환경에 포함되어 있기 때문에 네트워크 장치 중 하나를 사용하여 브리지로 구현되는 관리 네트워크가 있습니다. 클러스터에 추가된 필수 논리적 네트워크는 각 호스트의 네트워크 인터페이스와 연결되어 있어야 클러스터에 대해 작동할 수 있습니다.

가상 머신 계층

논리적 네트워크는 물리적 시스템에서 네트워크를 사용할 수 있는 것과 동일한 방식으로 가상 시스템에서 사용할 수 있도록 설정할 수 있습니다. 가상 머신은 가상 NIC를 실행하는 호스트에 구현된 모든 가상 머신 논리 네트워크에 연결할 수 있습니다. 그러면 가상 머신은 연결된 논리 네트워크에서 사용할 수 있는 다른 장치 또는 대상에 연결됩니다.

예 1.1. 관리 네트워크

ovirtmgmt라는 관리 논리 네트워크는 Red Hat Virtualization Manager가 설치되면 자동으로 생성됩니다.ovirtmgmt네트워크는 Red Hat Virtualization Manager와 호스트 간의 관리 트래픽 전용입니다. 특별히 설계된 다른 브릿지가 설정되지 않은 경우ovirtmgmt는 모든 트래픽의 기본 브릿지입니다.

1.7. 데이터 센터

- 스토리지 컨테이너에 는 스토리지 도메인의 연결 정보를 포함하여 스토리지 유형 및 스토리지 도메인에 대한 정보가 있습니다. 스토리지는 데이터 센터에 정의되며 데이터 센터의 모든 클러스터에서 사용할 수 있습니다. 데이터 센터 내의 모든 호스트 클러스터는 동일한 스토리지 도메인에 액세스할 수 있습니다.

- 네트워크 컨테이너에 는 데이터 센터의 논리적 네트워크에 대한 정보가 있습니다. 여기에는 네트워크 주소, VLAN 태그 및 STP 지원과 같은 세부 정보가 포함됩니다. 논리 네트워크는 데이터 센터에 정의되며, 선택적으로 클러스터 수준에서 구현됩니다.

- 클러스터 컨테이너에는 클러스터 가 있습니다. 클러스터는 호환 가능한 프로세서 코어( AMD 또는 Intel 프로세서)를 사용하는 호스트 그룹입니다. 클러스터는 마이그레이션 도메인입니다. 가상 머신은 다른 클러스터가 아닌 클러스터 내의 모든 호스트로 실시간으로 마이그레이션할 수 있습니다. 하나의 데이터 센터에는 여러 클러스터를 보유할 수 있으며 각 클러스터는 여러 호스트를 포함할 수 있습니다.

2장. 스토리지

2.1. 스토리지 도메인 개요

2.2. 스토리지 백엔드 스토리지 도메인 유형

- 파일 기반 스토리지

- Red Hat Virtualization에서 지원하는 파일 기반 스토리지 유형은 NFS, GlusterFS, 기타 POSIX 호환 파일 시스템 및 호스트의 로컬 스토리지입니다.파일 기반 스토리지는 Red Hat Virtualization 환경으로 외부에서 관리됩니다.NFS 스토리지는 Red Hat Enterprise Linux NFS 서버 또는 기타 타사 네트워크 연결 스토리지 서버에서 관리합니다.호스트는 자체 로컬 스토리지 파일 시스템을 관리할 수 있습니다.

- 블록 기반 스토리지

- 블록 스토리지는 포맷되지 않은 블록 장치를 사용합니다. 블록 장치는 LVM(Logical Volume Manager)에 의해 볼륨 그룹으로 집계됩니다. LVM의 인스턴스는 모든 호스트에서 실행되며, 다른 호스트에서 실행되는 인스턴스를 인식하지 못합니다. VDSM은 변경 사항을 위해 볼륨 그룹을 스캔하여 LVM 상단에 클러스터링 논리를 추가합니다. 변경 사항이 감지되면 VDSM은 볼륨 그룹 정보를 새로 고침하도록 지시하여 개별 호스트를 업데이트합니다. 호스트는 볼륨 그룹을 논리 볼륨으로 분할하여 논리 볼륨 메타데이터를 디스크에 씁니다. 기존 스토리지 도메인에 스토리지 용량이 더 추가되면 Red Hat Virtualization Manager를 통해 각 호스트에서 VDSM이 볼륨 그룹 정보를 새로 고칩니다.논리 단위 번호(LUN)는 개별 블록 장치입니다. 지원되는 블록 스토리지 프로토콜 중 하나인 iSCSI, FCoE 또는 SAS를 사용하여 LUN에 연결합니다. Red Hat Virtualization Manager는 LUN에 대한 소프트웨어 iSCSI 연결을 관리합니다. 다른 모든 블록 스토리지 연결은 Red Hat Virtualization 환경에서 외부에서 관리됩니다. 논리 볼륨 생성, 논리 볼륨 확장 또는 삭제, 새 LUN 추가와 같은 블록 기반 스토리지 환경의 모든 변경 사항은 스토리지 풀 관리자라는 특별히 선택한 호스트에서 LVM에 의해 처리됩니다. 그런 다음 VDSM에서 변경 사항을 동기화하여 클러스터의 모든 호스트에서 스토리지 메타데이터를 새로 고칩니다.

2.3. 스토리지 도메인 유형

- Data Storage Domain 은 Red Hat Virtualization 환경에 있는 모든 가상 머신의 하드 디스크 이미지를 저장합니다. 디스크 이미지에는 설치된 운영 체제 또는 가상 머신에서 저장되거나 생성된 데이터가 포함될 수 있습니다. 데이터 스토리지 도메인은 NFS, iSCSI, FCP, GlusterFS 및 POSIX 호환 스토리지를 지원합니다. 데이터 도메인은 여러 데이터 센터 간에 공유할 수 없습니다.

- Export Storage Domain 은 하드 디스크 이미지와 데이터 센터 간에 전송되는 가상 머신 템플릿을 위한 전송 스토리지를 제공합니다. 또한 내보내기 스토리지 도메인은 가상 머신 복사본을 백업합니다. 내보내기 스토리지 도메인은 NFS 스토리지를 지원합니다. 여러 데이터 센터에서 단일 내보내기 스토리지 도메인에 액세스할 수 있지만 한 번에 하나의 데이터 센터만 사용할 수 있습니다.

- ISO 스토리지 도메인 은 이미지라고도 하는 ISO 파일을 저장합니다. ISO 파일은 물리적 CD 또는 DVD의 표현입니다. Red Hat Virtualization 환경에서 일반적인 ISO 파일은 운영 체제 설치 디스크, 애플리케이션 설치 디스크 및 게스트 에이전트 설치 디스크입니다. 이러한 이미지는 가상 머신에 연결하고 물리적 디스크가 디스크 드라이브에 삽입되고 부팅되는 것과 동일한 방식으로 부팅될 수 있습니다. ISO 스토리지 도메인을 사용하면 데이터 센터 내의 모든 호스트가 ISO를 공유할 수 있으므로 물리적 미디어가 필요하지 않습니다.

2.4. 가상 디스크 이미지의 스토리지 형식

- QCOW2 포맷 가상 머신 스토리지

- QCOW2는 가상 디스크 이미지의 스토리지 형식입니다. QCOW 는 쓰기 시 QEMU 사본 입니다. QCOW2 형식은 논리 블록과 물리 블록 간에 매핑을 추가하여 가상 계층에서 물리 스토리지 계층을 분리합니다. 각 논리 블록은 물리적 오프셋에 매핑되어 스토리지 과다 커밋 및 가상 시스템 스냅샷을 활성화합니다. 각 QCOW 볼륨은 기본 디스크 이미지에 대한 변경 사항만 나타냅니다.초기 매핑은 모든 논리 블록을 백업 파일 또는 볼륨의 오프셋으로 가리킵니다. 가상 머신이 스냅샷 후 QCOW2 볼륨에 데이터를 쓰는 경우 백업 볼륨에서 관련 블록을 읽고 새 정보를 사용하여 수정하고 새 스냅샷 QCOW2 볼륨에 기록됩니다. 그런 다음 맵이 새 위치를 가리키도록 업데이트됩니다.

- RAW

- RAW 스토리지 형식은 QCOW2보다 성능 이점이 있으므로 RAW 형식으로 저장된 가상 디스크 이미지에 포맷이 적용되지 않습니다. RAW 형식으로 저장된 디스크 이미지의 가상 머신 데이터 작업에는 호스트의 추가 작업이 필요하지 않습니다. 가상 시스템이 가상 디스크의 지정된 오프셋에 데이터를 쓰는 경우 백업 파일 또는 논리 볼륨의 동일한 오프셋에 I/O가 기록됩니다.원시 형식을 사용하려면 스토리지 어레이에서 외부에서 관리되는 씬 프로비저닝 LUN을 사용하지 않는 한 정의된 이미지의 전체 공간을 사전 할당해야 합니다.

2.5. 가상 디스크 이미지 스토리지 hieradata 정책

- 사전 할당된 스토리지

- 가상 머신 생성 전에 가상 디스크 이미지에 필요한 모든 스토리지가 할당됩니다. 가상 머신에 대해 20GB 디스크 이미지가 생성되는 경우 디스크 이미지는 20GB의 스토리지 도메인 용량을 사용합니다. 사전 할당된 디스크 이미지는 사용할 수 없습니다. 유연성을 고려하여 런타임 중에 스토리지 할당이 발생하지 않으므로 스토리지 사전 할당이 더 빠른 쓰기 시간을 의미할 수 있습니다. 따라서 스토리지를 할당하면 Red Hat Virtualization Manager의 용량을 줄여 스토리지를 과다 할당할 수 있습니다. 사전 할당된 스토리지는 스토리지의 대기 시간을 줄이기 위해 고가성 I/O 작업에 사용되는 가상 머신에 권장됩니다. 일반적으로 서버 가상 머신은 이 설명에 적합합니다.참고스토리지 백엔드에서 제공하는 씬 프로비저닝 기능을 사용하는 경우 가상 머신의 스토리지를 프로비저닝할 때 사전 할당된 스토리지를 관리 포털에서 계속 선택해야 합니다.

- sparsely Allocated Storage

- 가상 디스크 이미지의 상한 크기 제한은 가상 머신 생성 시 설정됩니다. 처음에는 디스크 이미지에서 스토리지 도메인 용량을 사용하지 않습니다. 대문자에 도달할 때까지 가상 머신에서 디스크에 데이터를 쓸 때 사용량이 증가합니다. 디스크 이미지의 데이터가 제거되면 용량이 스토리지 도메인에 반환되지 않습니다. 스파스로 할당된 스토리지는 스토리지 대기 시간을 위해 다소 허용 오차가 낮거나 중간 수준의 I/O 작업이 있는 가상 머신에 적합합니다. 일반적으로 데스크탑 가상 머신은 이 설명에 적합합니다.참고스토리지 백엔드에서 씬 프로비저닝 기능을 제공하는 경우 씬 프로비저닝의 기본 구현으로 사용해야 합니다. 스토리지는 미리 할당된 그래픽 사용자 인터페이스에서 프로비저닝해야 하며 백엔드 솔루션으로 씬 프로비저닝을 유지해야 합니다.

2.6. Red Hat Virtualization의 스토리지 메타데이터 버전

- V1 메타데이터 (Red Hat Virtualization 2.x 시리즈)각 스토리지 도메인에는 자체 구조와 가상 디스크 이미지를 지원하는 데 사용되는 물리 볼륨의 이름을 설명하는 메타데이터가 포함되어 있습니다.마스터 도메인에는 스토리지 풀의 모든 도메인 및 물리 볼륨 이름에 대한 메타데이터도 포함됩니다. 이 메타데이터의 총 크기는 2KB로 제한되므로 풀에 있을 수 있는 스토리지 도메인 수를 제한합니다.템플릿 및 가상 머신 기본 이미지만 읽습니다.V1 메타데이터는 NFS, iSCSI 및 FC 스토리지 도메인에 적용할 수 있습니다.

- V2 메타데이터 (Red Hat Enterprise Virtualization 3.0)모든 스토리지 도메인 및 풀 메타데이터는 논리 볼륨에 기록되지 않고 논리 볼륨 태그로 저장됩니다. 가상 디스크 볼륨에 대한 메타데이터는 여전히 도메인의 논리 볼륨에 저장됩니다.물리 볼륨 이름은 더 이상 메타데이터에 포함되지 않습니다.템플릿 및 가상 머신 기본 이미지만 읽습니다.V2 메타데이터는 iSCSI 및 FC 스토리지 도메인에 적용할 수 있습니다.

- V3 메타데이터 (Red Hat Enterprise Virtualization 3.1 이상)모든 스토리지 도메인 및 풀 메타데이터는 논리 볼륨에 기록되지 않고 논리 볼륨 태그로 저장됩니다. 가상 디스크 볼륨에 대한 메타데이터는 여전히 도메인의 논리 볼륨에 저장됩니다.가상 머신 및 템플릿 기본 이미지는 더 이상 읽기 전용이 아닙니다. 이러한 변경으로 인해 스냅샷에서 실시간 스냅샷, 실시간 스토리지 마이그레이션 및 복제가 가능합니다.영어가 아닌 볼륨 이름에 대한 지원이 추가되었습니다.V3 메타데이터는 NFS, GlusterFS, POSIX, iSCSI, FC 스토리지 도메인에 적용할 수 있습니다.

2.7. Red Hat Virtualization의 스토리지 도메인 자동 복구

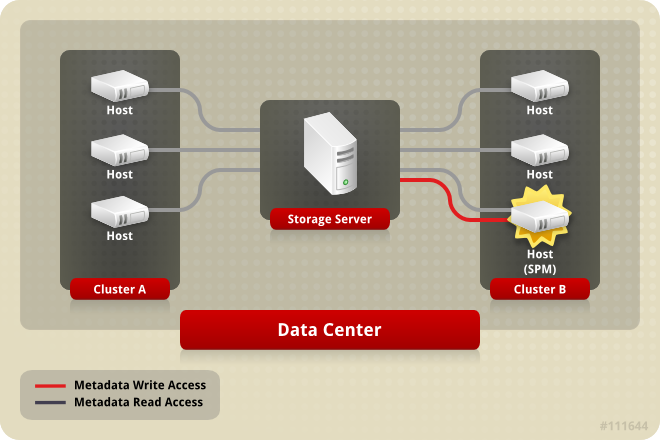

2.8. 스토리지 풀 관리자

리스 라는 마스터 스토리지 도메인의 특수 논리 볼륨에 작성됩니다. 데이터 도메인 구조에 대한 메타데이터는 메타데이터 라는 특수 논리 볼륨에 기록됩니다. 메타데이터 논리 볼륨 변경 사항은 임대 논리 볼륨에 의해 보호됩니다.

spmStart 명령을 실행하여 해당 호스트의 VDSM이 스토리지 중심 리스를 가정하려고 합니다. 호스트가 성공하면 Red Hat Virtualization Manager에서 새 호스트의 역할을 추측할 때까지 Red Hat Virtualization Manager에서 스토리지 중심 리스를 유지합니다.

- ECDHE 호스트는 모든 스토리지 도메인에 액세스할 수 없지만 마스터 스토리지 도메인에 액세스할 수 있습니다.

- storage connection의 손실 또는 리스 볼륨이 가득 차 있고 쓰기 작업을 수행할 수 없기 때문에 host는 리스를 갱신할 수 없습니다.

- gradle 호스트가 충돌합니다.

그림 2.1. 스토리지 풀 관리자는 예외적으로 구조적 메타데이터를 작성합니다.

2.9. 스토리지 풀 관리자 선택 프로세스

- "getSPMstatus" 명령: Manager는 VDSM을 사용하여 status가 last이고 "SPM", "Contending" 또는 "Free" 중 하나를 수신하는 호스트를 확인합니다.

- 스토리지 도메인의 메타데이터 볼륨에는 최신 상태가 있는 마지막 호스트가 포함되어 있습니다.

- 스토리지 도메인의 메타데이터 볼륨에는 status가 있는 마지막 호스트 버전이 포함되어 있습니다.

2.10. Red Hat Virtualization의 전용 리소스 및 Sanlock

2.11. 씬 프로비저닝 및 스토리지 과다 할당

2.12. 논리 볼륨 확장

3장. 네트워크

3.1. 네트워크 아키텍처

3.2. 소개: 기본 네트워킹 약관

- NIC(네트워크 인터페이스 컨트롤러)

- 브리지

- 관련 리뷰: A Bond

- A Virtual NIC

- 가상 LAN(VLAN)

3.3. 네트워크 인터페이스 컨트롤러

3.4. Bridge

3.5. 본딩

본딩 모드

모드 0 (round-robin policy)- 네트워크 인터페이스 카드를 순차순으로 전송합니다. 패킷은 본딩에서 사용 가능한 첫 번째 네트워크 인터페이스 카드로 시작하고 본딩에서 사용 가능한 마지막 네트워크 인터페이스 카드로 끝나는 루프로 전송됩니다. 이후의 모든 루프는 사용 가능한 첫 번째 네트워크 인터페이스 카드로 시작합니다. 모드 0은 내결함성을 제공하며 본딩의 모든 네트워크 인터페이스 카드의 부하를 조정합니다. 그러나 모드 0은 브리지와 함께 사용할 수 없으므로 가상 머신 논리 네트워크와 호환되지 않습니다.

모드 1 (active-backup 정책)- 하나의 네트워크 인터페이스 카드가 활성 상태로 유지되는 동안 모든 네트워크 인터페이스 카드를 백업 상태로 설정합니다. 활성 네트워크 인터페이스 카드의 오류가 발생하는 경우 백업 네트워크 인터페이스 카드 중 하나가 해당 네트워크 인터페이스 카드를 본딩에서 유일한 활성 네트워크 인터페이스 카드로 대체합니다. 모드 1의 MAC 주소는 활성 네트워크 인터페이스 카드의 MAC 주소를 반영하도록 본딩의 MAC 주소가 변경된 경우 발생할 수 있는 혼동을 방지하기 위해 하나의 포트에만 표시됩니다. 모드 1은 내결함성을 제공하며 Red Hat Virtualization에서 지원됩니다.

모드 2 (XOR 정책)- 소스 및 대상 MAC 주소 modulo 네트워크 인터페이스 카드 슬레이브 수에 대한 XOR 작업 결과에 따라 패킷을 전송할 네트워크 인터페이스 카드를 선택합니다. 이 계산을 통해 사용되는 각 대상 MAC 주소에 대해 동일한 네트워크 인터페이스 카드가 선택됩니다. 모드 2는 내결함성과 로드 밸런싱을 제공하며 Red Hat Virtualization에서 지원됩니다.

모드 3 (브로드캐스트 정책)- 모든 패킷을 모든 네트워크 인터페이스 카드에 전송합니다. 모드 3은 내결함성을 제공하며 Red Hat Virtualization에서 지원됩니다.

모드 4 (IEEE 802.3ad 정책)- 인터페이스가 동일한 속도와 듀플렉스 설정을 공유하는 집계 그룹을 만듭니다. 모드 4는 IEEE 802.3ad 사양에 따라 활성 집계 그룹의 모든 네트워크 인터페이스 카드를 사용하며 Red Hat Virtualization에서 지원됩니다.

모드 5 (Aptive 전송 로드 밸런싱 정책)- 본딩의 각 네트워크 인터페이스 카드에 대한 발신 트래픽 계정을 배포하고 현재 네트워크 인터페이스 카드가 들어오는 모든 트래픽을 수신하는지 확인합니다. 트래픽을 수신하도록 할당된 네트워크 인터페이스 카드가 실패하면 수신되는 트래픽을 수신하는 역할에 다른 네트워크 인터페이스 카드가 할당됩니다. 모드 5는 브리지와 함께 사용할 수 없으므로 가상 시스템 논리 네트워크와 호환되지 않습니다.

모드 6 (Aptive 로드 밸런싱 정책)- 모드 5(Aptive 전송 로드 밸런싱 정책)를 특정 스위치 요구 사항 없이 IPv4 트래픽에 대한 수신 부하 분산과 결합합니다. ARP 협상은 수신 로드의 균형을 조정하는 데 사용됩니다. 모드 6은 브리지와 함께 사용할 수 없으므로 가상 시스템 논리 네트워크와 호환되지 않습니다.

3.6. 본딩을 위한 스위치 구성

3.7. 가상 네트워크 인터페이스 카드

libvirt 에서 가상 네트워크 인터페이스 카드에 PCI 주소를 할당합니다. 그런 다음 MAC 주소와 PCI 주소는 가상 머신에서 가상 네트워크 인터페이스 카드(예: eth0)의 이름을 가져오는 데 사용됩니다.

[root@rhev-host-01 ~]# ip addr show

1: lo: <LOOPBACK,UP,LOWER_UP> mtu 16436 qdisc noqueue state UNKNOWN

link/loopback 00:00:00:00:00:00 brd 00:00:00:00:00:00

inet 127.0.0.1/8 scope host lo

inet6 ::1/128 scope host

valid_lft forever preferred_lft forever

2: eth0: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc pfifo_fast state UP qlen 1000

link/ether 00:21:86:a2:85:cd brd ff:ff:ff:ff:ff:ff

inet6 fe80::221:86ff:fea2:85cd/64 scope link

valid_lft forever preferred_lft forever

3: wlan0: <NO-CARRIER,BROADCAST,MULTICAST,UP> mtu 1500 qdisc mq state DOWN qlen 1000

link/ether 00:21:6b:cc:14:6c brd ff:ff:ff:ff:ff:ff

5: ;vdsmdummy;: <BROADCAST,MULTICAST> mtu 1500 qdisc noop state DOWN

link/ether 4a:d5:52:c2:7f:4b brd ff:ff:ff:ff:ff:ff

6: bond0: <BROADCAST,MULTICAST,MASTER> mtu 1500 qdisc noop state DOWN

link/ether 00:00:00:00:00:00 brd ff:ff:ff:ff:ff:ff

7: bond4: <BROADCAST,MULTICAST,MASTER> mtu 1500 qdisc noop state DOWN

link/ether 00:00:00:00:00:00 brd ff:ff:ff:ff:ff:ff

8: bond1: <BROADCAST,MULTICAST,MASTER> mtu 1500 qdisc noop state DOWN

link/ether 00:00:00:00:00:00 brd ff:ff:ff:ff:ff:ff

9: bond2: <BROADCAST,MULTICAST,MASTER> mtu 1500 qdisc noop state DOWN

link/ether 00:00:00:00:00:00 brd ff:ff:ff:ff:ff:ff

10: bond3: <BROADCAST,MULTICAST,MASTER> mtu 1500 qdisc noop state DOWN

link/ether 00:00:00:00:00:00 brd ff:ff:ff:ff:ff:ff

11: ovirtmgmt: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc noqueue state UNKNOWN

link/ether 00:21:86:a2:85:cd brd ff:ff:ff:ff:ff:ff

inet 10.64.32.134/23 brd 10.64.33.255 scope global ovirtmgmt

inet6 fe80::221:86ff:fea2:85cd/64 scope link

valid_lft forever preferred_lft forever

lo), 하나의 이더넷 장치(eth0), 하나의 무선 장치(wlan0), 1개의 VDSM 더미 장치(;vdsmdummy;), 5개의 본딩 장치(bond0,bond4,bond1, bond2 ,bond2 ), 하나의 네트워크 브리지(ovirtmgmt)를 표시합니다.[root@rhev-host-01 ~]# brctl show bridge name bridge id STP enabled interfaces ovirtmgmt 8000.e41f13b7fdd4 no vnet002 vnet001 vnet000 eth0

ovirtmgmt 브리지의 멤버임을 보여줍니다. 가상 네트워크 인터페이스 카드가 연결된 모든 가상 머신은 ovirtmgmt 논리적 네트워크에 연결됩니다. eth0 네트워크 인터페이스 카드는 ovirtmgmt 브리지의 멤버이기도 합니다. eth0 장치는 호스트 이외의 연결을 제공하는 스위치로 연결됩니다.

3.8. 가상 LAN(VLAN)

3.9. 네트워크 라벨

네트워크 라벨"

- 논리 네트워크에 레이블을 연결하면 해당 논리 네트워크가 지정된 레이블과 물리적 호스트 네트워크 인터페이스와 자동으로 연결됩니다.

- 물리적 호스트 네트워크 인터페이스에 레이블을 연결하면 지정된 레이블이 있는 모든 논리적 네트워크가 해당 물리적 호스트 네트워크 인터페이스와 자동으로 연결됩니다.

- 논리 네트워크 또는 물리적 호스트 네트워크 인터페이스에 연결된 레이블을 변경하면 레이블을 제거하고 새 레이블을 추가하는 것과 동일한 방식으로 작동합니다. 관련 논리적 네트워크 또는 물리적 호스트 네트워크 인터페이스 간의 연결이 업데이트됩니다.

네트워크 라벨 및 클러스터

- 레이블이 지정된 논리 네트워크가 클러스터에 추가되고 해당 클러스터에 동일한 레이블이 있는 물리적 호스트 네트워크 인터페이스가 있으면 논리 네트워크가 해당 물리적 호스트 네트워크 인터페이스에 자동으로 추가됩니다.

- 레이블이 지정된 논리 네트워크가 클러스터에서 분리되고 해당 클러스터에 동일한 레이블이 있는 물리적 호스트 네트워크 인터페이스가 있으면 논리 네트워크가 해당 물리적 호스트 네트워크 인터페이스에서 자동으로 분리됩니다.

역할을 사용하는 네트워크 라벨 및 논리 네트워크

- 레이블이 지정된 논리 네트워크가 디스플레이 네트워크 또는 마이그레이션 네트워크로 작동하도록 할당되면 해당 논리 네트워크가 DHCP 를 사용하여 물리적 호스트 네트워크 인터페이스에 구성되므로 논리적 네트워크에 IP 주소가 할당될 수 있습니다.역할 네트워크(예: "마이그레이션 네트워크" 또는 "표시 네트워크")에 레이블을 설정하면 모든 호스트에 해당 네트워크를 대량으로 배포합니다. 이러한 네트워크 추가는 DHCP를 사용하여 수행됩니다. 이 대량 배포 방법은 많은 고정 IP 주소 입력 작업의 확장 불가능한 특성으로 인해 정적 주소 입력 방법을 통해 선택되었습니다.

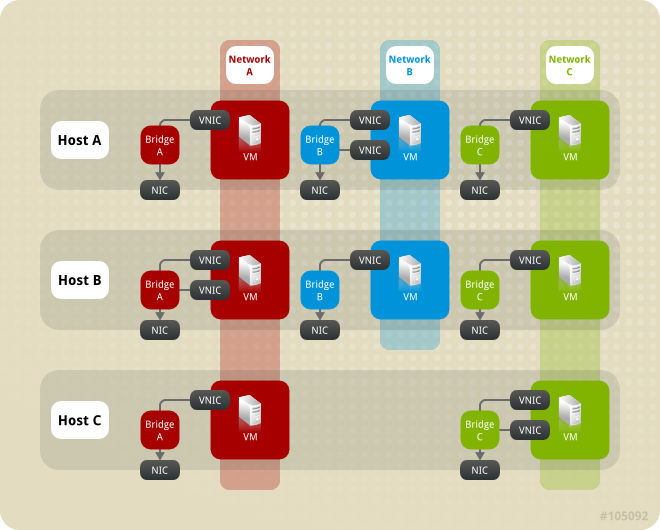

3.10. 클러스터 네트워킹

- 클러스터

- 논리 네트워크

그림 3.1. 클러스터 내의 네트워킹

3.11. 논리 네트워크

ovirtmgmt 네트워크는 Manager와 호스트 간의 관리 통신에 사용할 Red Hat Virtualization을 설치하는 동안 기본적으로 생성됩니다. 일반적으로 논리적 네트워크에 사용하는 것은 유사한 요구 사항 및 사용으로 네트워크 트래픽을 그룹화하는 것입니다. 대부분의 경우 관리자가 스토리지 네트워크 및 디스플레이 네트워크를 생성하여 최적화 및 문제 해결을 위해 각 유형의 트래픽을 분리합니다.

- 가상 머신 네트워크 트래픽을 전송하는 논리적 네트워크

- 가상 시스템 네트워크 트래픽을 전송하지 않는 논리 네트워크

- 선택적 논리적 네트워크

- 및 필수 네트워크

그림 3.2. ovirtmgmt 논리적 네트워크입니다.

예 3.1. 논리 네트워크의 사용 예.

ovirtmgmt 를 사용하고 있습니다. Pink를 담당하는 시스템 관리자는 웹 서버와 일부 클라이언트 가상 머신을 별도의 논리적 네트워크에 배치하여 웹 서버에 대한 네트워크 테스트를 분리하기로 결정합니다. 새 논리적 네트워크 network_testing 이라고 합니다.

network_testing 네트워크에 추가하여 해당 브릿지를 클러스터의 모든 호스트에서 설정해야 하기 때문입니다. 다음으로 화이트를 활성화하고 실행 중인 모든 가상 머신을 Red Hat에서 마이그레이션한 후 Red Hat의 프로세스를 반복합니다.

network_testing 논리 네트워크를 물리적 네트워크 인터페이스에 브리지하는 경우 network_testing 논리 네트워크가 operation이 되어 가상 시스템에서 사용할 수 있습니다.

3.12. 필수 네트워크, 선택적 네트워크 및 가상 머신 네트워크

3.13. 가상 머신 연결

ovirtmgmt 논리 네트워크에 있는 경우 해당 가상 시스템이 실행되는 호스트의 ovirtmgmt 브리지 멤버로 VNIC가 추가됩니다.

3.14. 포트 미러링

- 포트 미러링이 활성화된 프로필로 vNIC를 핫플러그하는 것은 지원되지 않습니다.

- vNIC 프로필이 가상 머신에 연결된 경우 포트 미러링을 변경할 수 없습니다.

3.15. 호스트 네트워킹 구성

- 브릿지 및 NIC 구성.

- 브리지, VLAN 및 NIC 구성입니다.

- 브리지, 본딩 및 VLAN 구성.

- 다중 브릿지, 여러 VLAN, NIC 구성

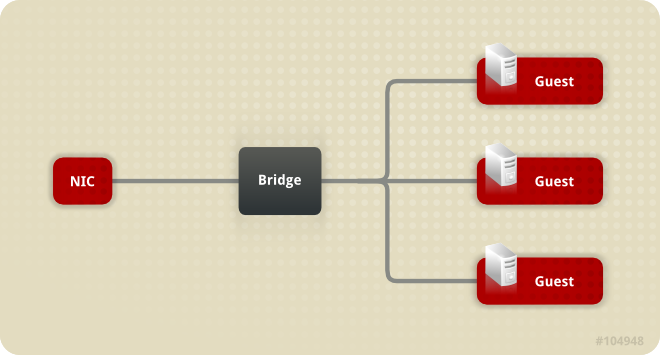

3.16. 브릿지 설정

그림 3.3. 브릿지 및 NIC 구성

ovirtmgmt 브릿지 자동 생성이 있습니다. 설치 시 Red Hat Virtualization Manager는 호스트에 VDSM 을 설치합니다. VDSM 설치 프로세스는 ovirtmgmt 브리지를 생성합니다. ovirtmgmt 브리지는 호스트의 IP 주소를 가져와 호스트에 대한 관리 통신을 활성화합니다.

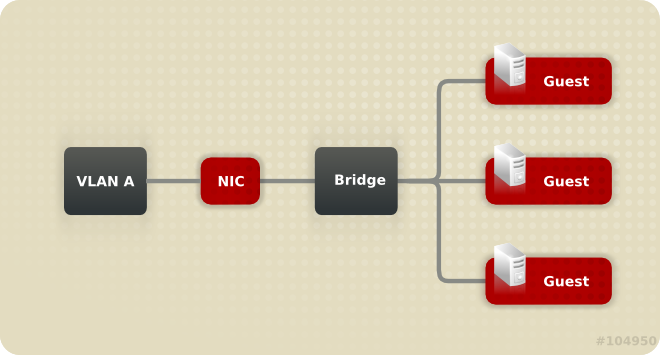

3.17. VLAN 설정

그림 3.4. 브리지, VLAN 및 NIC 구성

3.18. 브릿지 및 본딩 설정

그림 3.5. Bridge, Bond 및 NIC 설정

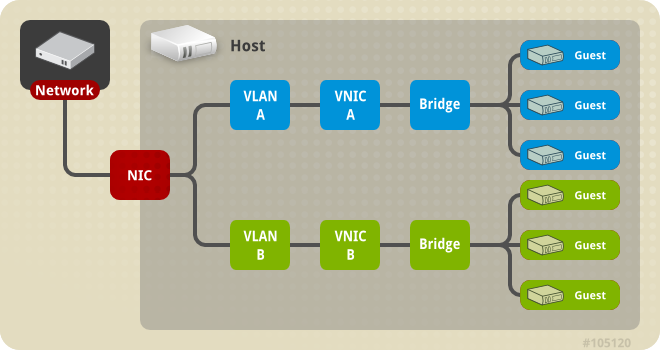

3.19. 다중 브리지, 다중 VLAN 및 NIC 설정

그림 3.6. 다중 브리지, 다중 VLAN 및 NIC 구성

3.20. 다중 브리지, 다중 VLAN 및 본딩 구성

그림 3.7. 여러 브릿지, 여러 VLAN, 본딩 연결을 통한 다중 NIC

4장. 전원 관리

4.1. 전원 관리 및 펜싱 소개

4.2. Red Hat Virtualization의 Proxy에 의한 전원 관리

- 펜싱이 필요한 호스트와 동일한 클러스터에 있는 호스트입니다.

- 펜싱이 필요한 호스트와 동일한 데이터 센터에 있는 모든 호스트입니다.

4.3. 전원 관리

- APC( American Power Conversion )입니다.

- BladeCenter.

- Cisco Unified Computing System (ciisco_ucs).

- Dell 원격 액세스 카드 5 (drac5).

- Dell 원격 액세스 카드 7 (drac7).

- 전자 전원 스위치 (eps)

- HP BladeSystem (하루드).

- 통합 Lights Out (ilo ilo2,ilo3,ilo4).

- 지능형 플랫폼 관리 인터페이스 (ipmilan).

- 원격 Supervisor Adapter (rsa)

- rsb.

- Western Telematic, Inc (Wti).

- status: 호스트의 상태를 점검합니다.

- Start: 호스트의 전원을 켭니다.

- stop: 호스트의 전원을 끕니다.

- 다시 시작: 호스트를 다시 시작하십시오. 실제로 stop, wait, status, start, wait, status로 구현됩니다.

4.4. 펜싱

4.5. 소프트 펜싱 호스트

- 첫 번째 네트워크 오류에서 호스트 상태가 "연결"으로 변경됩니다.

- 그러면 Manager에서 VDSM에 상태를 요청하거나 호스트의 부하에 따라 결정되는 간격을 기다립니다. 간격의 길이를 결정하는 공식은 TimeoutToResetVdsInSeconds (기본값은 60초) + [DelayResetPerVmInSeconds) * (호스트에서 가상 머신 실행 횟수) + [DelayResetForSpmInSeconds) * [DelayResetForSpmInSeconds (기본값) * (기본값은 20초) * (기본값은 0초) * (초) * (기본값: 0초) * (초)에 의해 구성됩니다. VDSM에 응답 시간을 최대로 제공하기 위해 Manager는 위에서 언급한 두 가지 옵션 중 더 긴 기간(양식 3개 또는 위 공식에 따라 결정된 간격)을 선택합니다.

- 해당 간격이 경과할 때 호스트가 응답하지 않으면 SSH를 통해 vdsm restart 가 실행됩니다.

- vdsm 재시작 이 호스트와 Manager 간 연결을 다시 설정하지 않으면 호스트의 상태가

Non Responsive로 변경되고 전원 관리가 구성된 경우 펜싱이 외부 펜싱 에이전트로 전달됩니다.

4.6. 다중 전원 관리 펜싱 에이전트 사용

- Concurrent: 주 및 보조 에이전트 모두 호스트를 중지하려면 Stop 명령에 응답해야 합니다. 하나의 에이전트가 Start 명령에 응답하는 경우 호스트는 가동됩니다.

- 순차적: 호스트를 중지하거나 시작하기 위해 기본 에이전트가 먼저 사용되며 실패하는 경우 보조 에이전트가 사용됩니다.

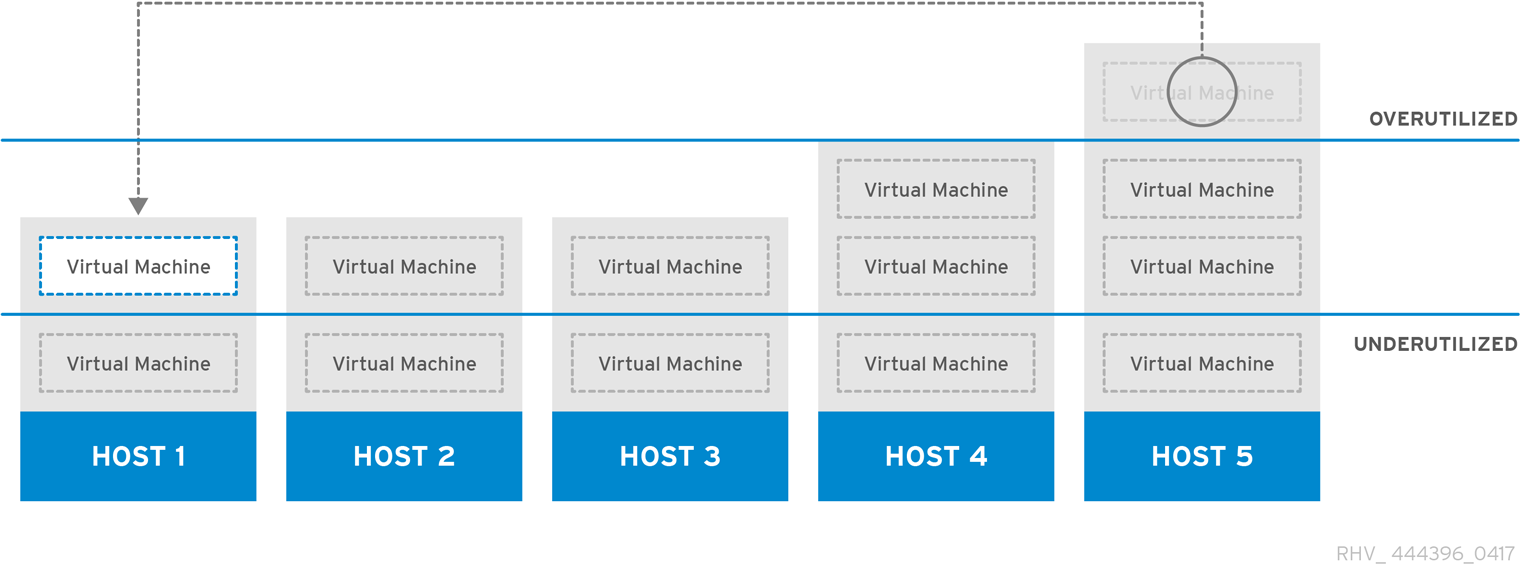

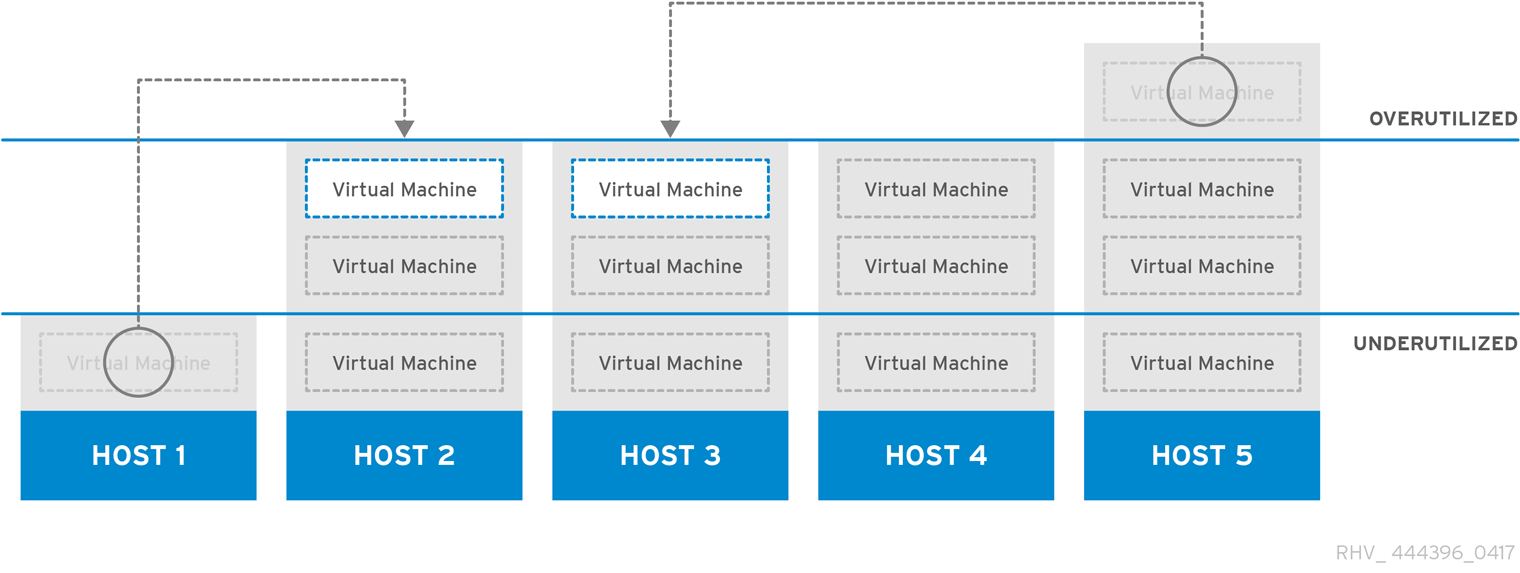

5장. 로드 밸런싱, 스케줄링 및 마이그레이션

5.1. 로드 밸런싱, 스케줄링 및 마이그레이션

- 가상 머신 시작 - 가상 시스템이 시작할 호스트를 결정하기 위해 리소스를 확인합니다.

- 가상 머신 마이그레이션 - 적절한 대상 호스트를 결정하기 위해 리소스를 확인합니다.

- 시간 경과 - 리소스를 정기적으로 확인하여 개별 호스트 로드가 클러스터 로드 밸런싱 정책을 준수하는지 확인합니다.

5.2. 로드 밸런싱 정책

5.3. 로드 밸런싱 정책: VM_Evenly_Distributed

5.4. 로드 밸런싱 정책: Evenly_Distributed

그림 5.1. 균등하게 분산 스케줄링 정책

5.5. 로드 밸런싱 정책: Power_Saving

그림 5.2. Power Saving Scheduling Policy

5.6. 로드 밸런싱 정책: 없음

5.7. 로드 밸런싱 정책: InClusterUpgrade

5.8. 고가용성 가상 머신

5.9. 스케줄링

5.10. Migration

- 52MiBps(초당 메가바이트)의 대역폭 제한이 각 가상 시스템 마이그레이션에 적용됩니다.

- 마이그레이션 시간은 GB의 가상 머신 메모리당 64초 후에 시간 초과됩니다.

- 진행이 2초 동안 중단되면 마이그레이션이 중단됩니다.

- 동시 발신 마이그레이션은 호스트당 CPU 코어당 1개 또는 2개 중 작은 것으로 제한됩니다.

6장. 디렉터리 서비스

6.1. 디렉터리 서비스

- 포털 로그인(사용자, 전원 사용자, 관리자, REST API).

- 사용자 정보를 표시하는 쿼리입니다.

- 도메인에 Manager 추가.

6.2. 로컬 인증: 내부 도메인

admin@internal 사용자 중 하나만 보유하므로 내부 도메인은 외부 도메인과도 다릅니다. 이 접근 방식을 초기 인증을 통해 완전한 기능 디렉터리 서버 없이도 Red Hat Virtualization을 평가할 수 있으며 관리 계정을 사용하여 외부 디렉터리 서비스의 문제를 해결할 수 있습니다.

6.3. GSSAPI를 사용한 원격 인증

engine-manage-domains 툴을 사용하여 RHDS, AD 또는 IdM 도메인의 일부로 관리자가 구성해야 합니다. 이를 위해서는 시스템을 도메인에 결합할 수 있는 충분한 권한이 있는 도메인의 RHDS, AD 또는 IdM 디렉터리 서버에서 계정에 대한 자격 증명을 관리자에게 제공해야 합니다. 도메인을 추가한 후 암호를 사용하여 디렉터리 서버에 대해 Red Hat Virtualization Manager에서 도메인 사용자를 인증할 수 있습니다. 관리자는 GSSAPI( Generic Security Services Application Program Interface )를 사용하여 사용자의 ID를 안전하게 확인하고 사용자가 사용할 수 있는 권한 부여 수준을 확인하는 데 GSSAPI( Simple Authentication and Security Layer )라는 프레임워크를 사용합니다.

그림 6.1. GSSAPI 인증

7장. 템플릿 및 풀

7.1. 템플릿 및 풀

7.2. 템플릿

7.3. 풀

예 7.1. 풀 사용량의 예

8장. 가상 머신 스냅샷

8.1. 스냅샷

- 가상 머신에 대해 생성된 첫 번째 스냅샷을 생성하는 생성.

- 미리 보기로 스냅샷을 미리 보고 스냅샷을 만든 시점으로 시스템 데이터를 복원할지 여부를 결정합니다.

- 더 이상 필요하지 않은 복원 지점을 삭제해야 합니다.

8.2. Red Hat Virtualization의 실시간 스냅샷

qemu-guest-agent 를 설치하여 스냅샷 전에 정지할 수 있습니다.

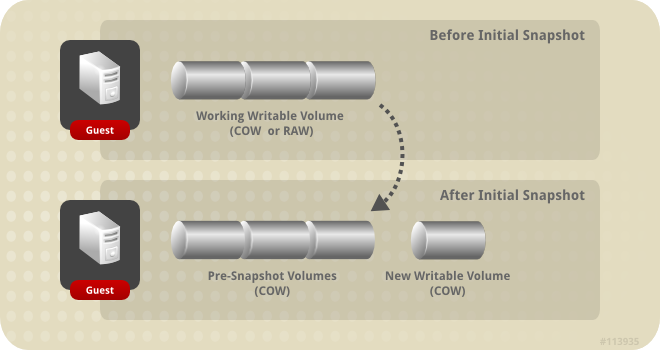

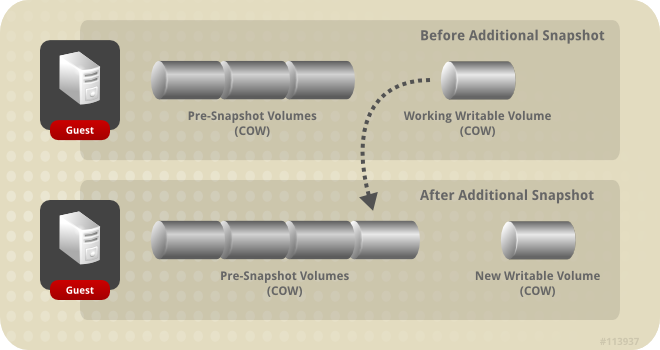

8.3. 스냅샷 생성

그림 8.1. 초기 스냅샷 생성

그림 8.2. 추가 스냅샷 생성

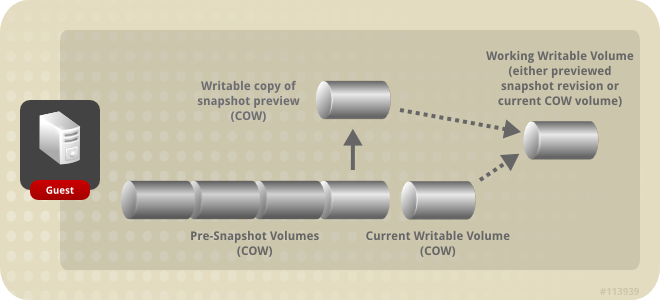

8.4. 스냅샷 프리뷰

그림 8.3. 스냅샷 프리뷰

8.5. 스냅샷 삭제

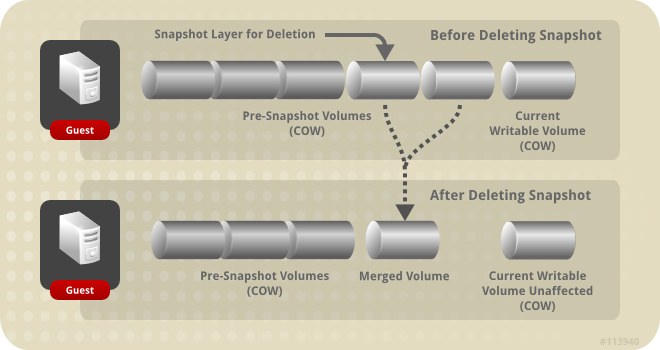

Delete_snapshot 스냅샷은 200GB이고 후속 스냅샷인 Next_snapshot 은 100GB입니다. Delete_snapshot 이 삭제되고 새 논리 볼륨이 일시적으로 이름이 Snapshot_merge 이고 크기가 200GB인 새 논리 볼륨이 생성됩니다. Snapshot_merge 는 결국 Delete_snapshot 및 Next_snapshot 의 병합된 총 콘텐츠를 수용하기 위해 300GB로 크기를 조정합니다. 그런 다음 Next_snapshot 의 이름이 Delete_me_too_snapshot 으로 변경되어 Snapshot_merge 의 이름을 Next_snapshot 으로 변경할 수 있습니다. 마지막으로 Delete_snapshot 및 Delete_me_too_snapshot 이 삭제됩니다.

그림 8.4. 스냅샷 삭제

9장. 하드웨어 드라이버 및 장치

9.1. Virtualized Hardware

- 에뮬레이션된 장치

- 가상 장치라고도 하는 에뮬레이션된 장치는 전적으로 소프트웨어에 존재합니다. 에뮬레이션된 장치 드라이버 는 호스트에서 실행되는 운영 체제(소스 장치를 관리하는) 및 게스트에서 실행되는 운영 체제 간의 변환 계층입니다. 에뮬레이션된 장치에서 및 로 들어오는 장치 수준 지침은 하이퍼바이저에 의해 가로채기 및 변환됩니다. Linux 커널에서 에뮬레이션 및 인식하는 것과 동일한 유형의 장치를 에뮬레이션된 드라이버의 백업 소스 장치로 사용할 수 있습니다.

- 반 가상화된 장치

- 반가상화된 장치에는 호스트 머신의 하이퍼바이저와 통신할 수 있는 인터페이스를 제공하는 게스트 운영 체제에 장치 드라이버를 설치해야 합니다. 이 인터페이스는 가상화된 환경 외부에서 디스크 I/O와 같은 집약적인 작업을 수행할 수 있도록 하는 데 사용됩니다. 이러한 방식으로 가상화에 내재된 오버헤드를 낮추는 것은 게스트 운영 체제 성능이 물리적 하드웨어에서 직접 실행될 때 예상하는 것과 더 가깝게 허용하기 위한 것입니다.

- 물리적 공유 장치

- 특정 하드웨어 플랫폼을 통해 가상화 게스트는 다양한 하드웨어 장치 및 구성 요소에 직접 액세스할 수 있습니다. 가상화의 이 프로세스를 passthrough 또는 장치 할당 이라고 합니다. 통과를 통해 장치가 게스트 운영 체제에 물리적으로 연결된 것처럼 보이고 작동할 수 있습니다.

9.2. Red Hat Virtualization에서 안정적인 장치 주소

9.3. 중앙 처리 장치(CPU)

9.4. 시스템 장치

- 호스트 브리지

- ISA 브리지 및 USB 브리지( USB 및 ISA 브리지는 동일한 장치임)

- 그래픽 카드(Cirrus 또는 qxl 드라이버 사용)

- 메모리 balloon 장치입니다.

9.5. 네트워크 장치

e1000네트워크 인터페이스 컨트롤러는 가상화된 Intel PRO/1000(e1000)을 게스트에 노출합니다.virtio네트워크 인터페이스 컨트롤러는 게스트에 반가상화 네트워크 장치를 노출합니다.rtl8139네트워크 인터페이스 컨트롤러는 가상화된Realtek Semiconductor Corp RTL8139를 게스트에 노출합니다.

9.6. 그래픽 장치

- ac97 은

Cirrus CLGD 5446 PCI VGA카드를 에뮬레이션합니다. - vga 는 BochsVESA 확장 (모든 비표준 모드 포함)으로 더미 VGA 카드를 에뮬레이션합니다.

9.7. 스토리지 장치

IDE드라이버는 게스트에 에뮬레이션된 블록 장치를 노출합니다. 에뮬레이션된IDE드라이버는 최대 4개의 가상화된IDE하드 디스크 또는 가상화된IDECD-ROM 드라이브를 각 가상화 게스트에 연결하는 데 사용할 수 있습니다. 에뮬레이션된IDE드라이버는 가상화된 DVD-ROM 드라이브를 제공하는 데도 사용됩니다.- VirtIO 드라이버는 반 가상화된 블록 장치를 게스트에 노출합니다. 반 가상화된 블록 드라이버는 가상화된 게스트에 연결된 하이퍼바이저에서 지원하는 모든 스토리지 장치에 대한 드라이버입니다(미러링해야 하는 유동 디스크 드라이브 제외).

9.8. 동영상 장치

- ac97 은

Intel 82801AA AC97의 AC97 호환 가능한 표시카드를 에뮬레이션합니다. - es1370 은

ENSONIQ audioPCI ES1370표시 카드를 에뮬레이션합니다.

9.9. 직렬 드라이버

virtio-serial)는 바이트 스트림 지향적 문자 스트림 드라이버입니다. 반 가상화된 직렬 드라이버는 네트워킹을 사용할 수 없거나 사용할 수 없는 게스트의 사용자 공간과 호스트의 사용자 공간 간의 간단한 통신 인터페이스를 제공합니다.

9.10. balloon 드라이버

10장. 최소 요구 사항 및 기술 제한

10.1. 최소 요구 사항 및 지원 제한

10.2. 리소스 제한

표 10.1. 리소스 제한

| 항목 | 제한 |

|---|---|

| 스토리지 도메인 | 데이터 센터당 최소 2개의 스토리지 도메인을 사용하는 것이 좋습니다.

|

| 호스트 | Red Hat은 Red Hat Virtualization Manager당 최대 200개의 호스트를 지원합니다. |

10.3. 클러스터 제한

- 모든 관리형 하이퍼바이저는 클러스터에 있어야 합니다.

- 클러스터 내의 모든 관리형 하이퍼바이저는 동일한 CPU 유형을 보유해야 합니다. Intel 및 AMD CPU는 동일한 클러스터 내에서 공존할 수 없습니다.

10.4. 스토리지 도메인 제한

표 10.2. 스토리지 도메인 제한

| 항목 | 제한 |

|---|---|

| 스토리지 유형 |

지원되는 스토리지 유형은 다음과 같습니다.

Red Hat Virtualization 4.0의 새로운 ISO 및 내보내기 스토리지 도메인은 모든 파일 기반 스토리지(NFS, Posix 또는 GlusterFS)에서 제공할 수 있습니다.

|

| 논리 단위 번호(LUN) | iSCSI 또는 FCP에서 제공하는 각 스토리지 도메인에 대해 300개 이상의 LUN이 허용되지 않습니다. |

| 논리 볼륨(LV) |

Red Hat Virtualization에서 논리 볼륨은 가상 머신, 템플릿 및 가상 머신 스냅샷의 가상 디스크를 나타냅니다.

iSCSI 또는 FCP에서 제공하는 각 스토리지 도메인에 350개 이상의 논리 볼륨이 권장됩니다. 지정된 스토리지 도메인의 논리 볼륨 수가 이 수를 초과하면 각각 350개 이상의 논리 볼륨이 없는 별도의 스토리지 도메인으로 사용 가능한 스토리지를 분할하는 것이 좋습니다.

이 제한의 근본 원인은 LVM 메타데이터의 크기입니다. 논리 볼륨의 수가 증가함에 따라 해당 논리 볼륨과 연결된 LVM 메타데이터도 증가합니다. 이 메타데이터의 크기가 1MB를 초과하면 새 디스크 또는 스냅샷 생성과 같은 프로비저닝 작업의 성능이 저하되고 QCOW 디스크를 실행하는 데 시간이 오래 걸리는 경우 논리 볼륨을 씬 프로비저닝하는 데 필요한 시간이 단축됩니다.

논리 볼륨에 대한 자세한 내용은 에서 https://access.redhat.com/solutions/441203 확인할 수 있습니다.

|

10.5. Red Hat Virtualization Manager 제한 사항

표 10.3. Red Hat Virtualization Manager 제한 사항

| 항목 | 제한 |

|---|---|

| RAM |

|

| PCI 장치 |

|

| 스토리지 |

|

10.6. 하이퍼바이저 요구 사항

표 10.4. Red Hat Virtualization 호스트 요구 사항 및 지원 제한

| 항목 | 지원 제한 |

|---|---|

| CPU |

최소 1개의 물리적 CPU가 필요합니다. Red Hat Virtualization은 호스트에서 이러한 CPU 모델의 사용을 지원합니다.

모든 CPU 는 Intel® 64 또는 AMD64 CPU 확장 기능을 지원하고 AMD-V™ 또는 Intel VT® 하드웨어 가상화 확장 기능이 활성화되어 있어야 합니다.

No eXecute 플래그 (NX) 지원도 필요합니다.

|

| RAM |

각 가상 시스템에 필요한 RAM의 크기는 다음 사항에 따라 다릅니다.

또한 KVM 은 가상 머신에 대해 물리적 RAM 을 초과 커밋할 수 있습니다. 필요에 따라 가상 머신의 RAM 을 할당하고 활용도가 낮은 가상 머신을 스왑으로 전환하여 이를 수행합니다.

지원되는 최대 RAM 및 최소 RAM은 을 참조하십시오 https://access.redhat.com/articles/rhel-limits.

|

| 스토리지 |

호스트에 지원되는 최소 내부 스토리지는 다음 목록의 합계입니다.

호스트 설치를 위한 최소 스토리지 요구 사항은 다음과 같습니다. 스토리지 공간을 더 많이 사용하는 기본 할당을 사용하는 것이 좋습니다.

|

| PCI 장치 |

최소 대역폭이 1Gbps인 경우 하나 이상의 네트워크 컨트롤러가 필요합니다.

|

Virtualization hardware is unavailable. (No virtualization hardware was detected on this system)

- 호스트 부팅 화면에서 아무 키나 눌러서 직렬 콘솔로 Boot 또는 Boot with serial console 항목을 선택합니다. Tab 을 눌러 선택한 옵션의 커널 매개 변수를 편집합니다. 마지막 커널 매개 변수가 나열된 후 Space 가 있는지 확인하고

rescue매개 변수를 추가합니다. - Enter 를 눌러 복구 모드로 부팅합니다.

- 표시되는 프롬프트에서 프로세서에 가상화 확장 기능이 있고 다음 명령을 실행하여 활성화되는지 확인합니다.

# grep -E 'svm|vmx' /proc/cpuinfo

출력이 표시되면 프로세서는 하드웨어 가상화가 가능합니다. 출력이 표시되지 않는 경우에도 프로세서가 하드웨어 가상화를 지원할 수 있습니다. 일부 상황에서는 제조업체가 BIOS에서 가상화 확장을 비활성화합니다. 이 경우 제조업체가 제공하는 시스템의 BIOS 및 마더보드 설명서를 참조하십시오. - 추가 검사로

kvm모듈이 커널에 로드되었는지 확인합니다.# lsmod | grep kvm

출력에kvm_intel또는kvm_amd가 포함된 경우kvm하드웨어 가상화 모듈이 로드되고 시스템이 요구 사항을 충족합니다.

10.7. 게스트 요구 사항 및 지원 제한

표 10.5. Virtualized Hardware

| 항목 | 제한 |

|---|---|

| CPU |

Red Hat Enterprise Linux 7에서는 게스트당 최대 4.6.1개의 가상화된 CPU가 지원됩니다.

|

| RAM |

게스트마다 다른 RAM 요구 사항이 있습니다. 각 게스트에 필요한 RAM의 양은 게스트 운영 체제의 요구 사항과 게스트가 작동하는 로드에 따라 다릅니다.

게스트 머신에 대해 지원되는 최대 RAM 및 최소 RAM은 을 참조하십시오 https://access.redhat.com/articles/rhel-kvm-limits.

|

| PCI 장치 |

게스트당 최대 31개의 가상화된 PCI 장치가 지원됩니다. 여러 시스템 장치는 이 제한에 대해 개수를 계산하며, 일부는 필수입니다. PCI 장치 제한에 대해 계산하는 필수 장치에는 PCI 호스트 브리지, ISA 브리지, USB 브리지, 보드 브리지, 그래픽 카드 및 IDE 또는 VirtIO 블록 장치가 포함됩니다.

|

| 스토리지 |

게스트당 최대 28개의 가상화 스토리지 장치가 지원되며, 가능한 3개의 IDE와 25개의 Virtio로 구성됩니다.

|

10.8. SPICE 제한

10.9. 참고 자료

- Red Hat Enterprise Linux - 시스템 관리자 가이드

- Red Hat Enterprise Linux의 배포, 구성 및 관리에 대한 가이드입니다.

- Red Hat Enterprise Linux - DM-Multipath 가이드

- Red Hat Enterprise Linux에서 장치-Mapper Multipathing 사용에 대한 가이드입니다.

- Red Hat Enterprise Linux - 설치 가이드

- Red Hat Enterprise Linux 설치에 대한 가이드입니다.

- Red Hat Enterprise Linux - 스토리지 관리 가이드

- Red Hat Enterprise Linux에서 스토리지 장치 및 파일 시스템 관리에 대한 가이드입니다.

- Red Hat Enterprise Linux - 가상화 배포 및 관리 가이드

- Red Hat Enterprise Linux에서 가상화 기술의 설치, 구성, 관리 및 문제 해결에 대한 가이드입니다.