네트워킹 가이드

Red Hat OpenStack Platform Networking에 대한 고급 가이드

OpenStack Documentation Team

rhos-docs@redhat.com초록

머리말

인스턴스를 생성하는 동안에는 RBAC(역할 기반 액세스 제어)-공유 보안 그룹을 인스턴스에 직접 적용할 수 없습니다. RBAC-shared 보안 그룹을 인스턴스에 적용하려면 먼저 포트를 생성하고, 공유 보안 그룹을 해당 포트에 적용한 다음 해당 포트를 인스턴스에 할당해야 합니다. 포트에 보안 그룹 추가를 참조하십시오.

보다 포괄적 수용을 위한 오픈 소스 용어 교체

Red Hat은 코드, 문서, 웹 속성에서 문제가 있는 용어를 교체하기 위해 최선을 다하고 있습니다. 먼저 마스터(master), 슬레이브(slave), 블랙리스트(blacklist), 화이트리스트(whitelist) 등 네 가지 용어를 교체하고 있습니다. 이러한 변경 작업은 작업 범위가 크므로 향후 여러 릴리스에 걸쳐 점차 구현할 예정입니다. 자세한 내용은 CTO Chris Wright의 메시지를 참조하십시오.

Red Hat 문서에 관한 피드백 제공

문서 개선을 위한 의견을 보내 주십시오. Red Hat이 어떻게 더 나은지 알려주십시오.

직접 문서 피드백(DDF) 기능 사용

피드백 추가 DDF 기능을 사용하여 특정 문장, 단락 또는 코드 블록에 대한 직접 의견을 제출할 수 있습니다.

- 다중 페이지 HTML 형식으로 문서를 봅니다.

- 문서의 오른쪽 상단에 피드백 버튼이 표시되는지 확인합니다.

- 주석 처리하려는 텍스트 부분을 강조 표시합니다.

- 피드백 추가를 클릭합니다.

- 코멘트를 사용하여 피드백 추가 필드를 완료합니다.

- 선택 사항: 문서 팀이 문제에 대한 자세한 설명을 위해 연락을 드릴 수 있도록 이메일 주소를 추가합니다.

- Submit(제출)을 클릭합니다.

1장. OpenStack 네트워킹 소개

Networking 서비스(neutron)는 RHOSP(Red Hat OpenStack Platform)의 소프트웨어 정의 네트워킹(SDN) 구성 요소입니다. RHOSP 네트워킹 서비스는 가상 머신 인스턴스로의 내부 및 외부 트래픽을 관리하고 라우팅, 분할, DHCP 및 메타데이터와 같은 핵심 서비스를 제공합니다. 가상 네트워킹 기능 및 스위치, 라우터, 포트 및 방화벽 관리를 위한 API를 제공합니다.

1.1. RHOSP 네트워크 관리

RHOSP(Red Hat OpenStack Platform) Networking 서비스(neutron)를 사용하면 사이트의 네트워킹 목표를 효과적으로 충족할 수 있습니다. 다음을 수행할 수 있습니다.

프로젝트 내의 VM 인스턴스에 대한 연결 제공.

프로젝트 네트워크는 주로 일반(권한이 없는) 프로젝트를 통해 관리자 없이 네트워크를 관리할 수 있습니다. 이러한 네트워크는 완전히 가상 네트워크이며 인터넷과 같은 다른 프로젝트 네트워크 및 외부 네트워크와 상호 작용하려면 가상 라우터가 필요합니다. 또한 프로젝트 네트워크는 일반적으로 인스턴스에 DHCP 및 메타데이터 서비스를 제공합니다. RHOSP에서는 플랫, VLAN, VXLAN, GRE, GENEVE의 프로젝트 네트워크 유형을 지원합니다.

자세한 내용은 프로젝트 네트워크 관리를 참조하십시오.

프로젝트 외부의 네트워크에 VM 인스턴스를 연결합니다.

공급자 네트워크는 프로젝트 네트워크와 같은 연결을 제공합니다. 하지만 관리(권한) 사용자만 해당 네트워크를 물리적 네트워크 인프라와 인터페이스하기 때문에 관리할 수 있습니다. RHOSP에서는 플랫 및 VLAN의 공급자 네트워크 유형을 지원합니다.

프로젝트 네트워크 내에서 유동 IP 주소 또는 단일 유동 IP 주소 풀을 사용하여 수신 트래픽을 VM 인스턴스로 보낼 수 있습니다. 브리지 매핑을 사용하면 물리적 네트워크 이름(인터페이스 레이블)을 OVS 또는 OVN으로 생성된 브리지에 연결하여 공급자 네트워크 트래픽이 물리적 네트워크에 도달할 수 있습니다.

자세한 내용은 VM 인스턴스 연결을 물리적 네트워크에 참조하십시오.

에지에 최적화된 네트워크를 만듭니다.

Operator는 에지 배포에서 일반적으로 사용되는 라우팅 공급자 네트워크(RPN)를 생성할 수 있으며 하나의 세그먼트만 있는 기존 네트워크 대신 여러 계층 2 네트워크 세그먼트에 의존합니다.

RPN은 하나의 네트워크만 볼 수 있기 때문에 최종 사용자를 위한 클라우드를 간소화합니다. 클라우드 운영자의 경우 RPN은 확장성과 내결함성을 제공합니다. 예를 들어 주요 오류가 발생하면 전체 네트워크 실패 대신 하나의 세그먼트만 영향을 받습니다.

자세한 내용은 라우팅된 공급자 네트워크 배포를 참조하십시오.

네트워크 리소스를 고가용성으로 만듭니다.

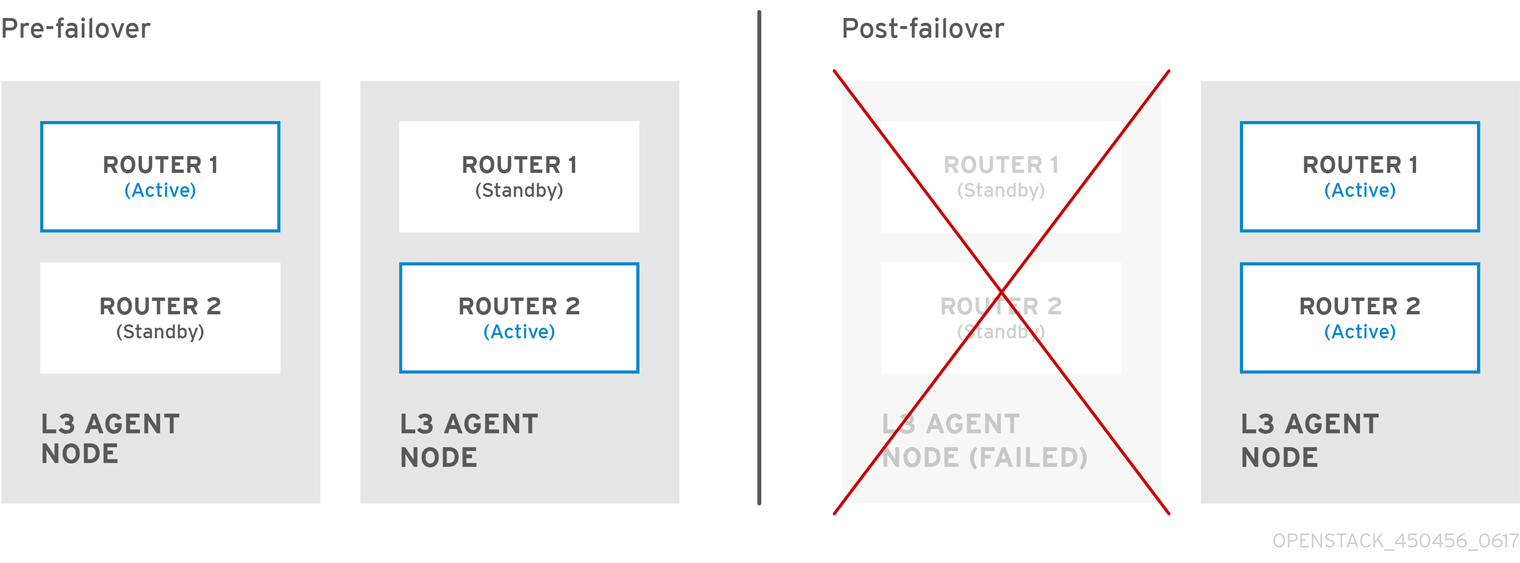

AZ(AZ) 및 VRRP(Virtual Router Redundancy Protocol)를 사용하여 네트워크 리소스를 고가용성으로 유지할 수 있습니다. Operator는 다른 AZ의 다른 전원 소스에 연결된 네트워크 노드를 그룹화합니다. 다음으로 Operator는 DHCP, L3, FW 등의 중요한 서비스를 별도의 AZ에 예약합니다.

RHOSP는 VRRP를 사용하여 프로젝트 라우터 및 유동 IP 주소를 고가용성으로 만듭니다. 중앙 집중식 라우팅인 DVR(Distributed Virtual Routing)은 L3 에이전트를 배포하고 모든 컴퓨팅 노드에 라우터를 예약하는 VRRP를 기반으로 하는 대체 라우팅 설계를 제공합니다.

자세한 내용은 가용성 영역 사용을 참조하여 네트워크 리소스를 고가용성으로 만듭니다.For more information, see Using availability zones to make network resources highly available.

포트 수준에서 네트워크를 보호합니다.

보안 그룹은 인스턴스에 바인딩되는 가상 방화벽 규칙 및 포트 수준에서 수신(인스턴스에서 바인딩) 네트워크 트래픽을 송신하는 컨테이너를 제공합니다. 보안 그룹은 기본 거부 정책을 사용하며 특정 트래픽을 허용하는 규칙만 포함합니다. 각 포트는 추가 방식으로 하나 이상의 보안 그룹을 참조할 수 있습니다. 방화벽 드라이버는 보안 그룹 규칙을 iptables와 같은 기본 패킷 필터링 기술의 구성으로 변환합니다.

자세한 내용은 공유 보안 그룹 구성을 참조하십시오.

포트 트래픽을 관리합니다.

허용되는 주소 쌍을 사용하면 네트워크 트래픽이 서브넷에 관계없이 포트를 통과할 수 있도록 특정 MAC 주소, IP 주소 또는 둘 다를 식별합니다. 허용된 주소 쌍을 정의할 때 빠른 데이터 플레인 페일오버를 활성화하기 위해 두 VM 인스턴스 간에 IP 주소를 복제하는 VRRP(Virtual Router Redundancy Protocol)와 같은 프로토콜을 사용할 수 있습니다.

자세한 내용은 허용되는 주소 쌍 구성을 참조하십시오.

대규모 오버레이 네트워크를 최적화합니다.

L2 인기 드라이버를 사용하면 대규모 오버레이 네트워크에서 브로드캐스트, 멀티 캐스트 및 유니캐스트 트래픽을 활성화할 수 있습니다.

자세한 내용은 L2 채우기 드라이버 구성을 참조하십시오.

VM 인스턴스의 트래픽에 대한 수신 및 송신 제한을 설정합니다.

QoS(Quality of Service) 정책을 사용하여 송신 및 수신 트래픽에 속도 제한을 적용하여 인스턴스에 대해 다양한 서비스 수준을 제공할 수 있습니다. 개별 포트에 QoS 정책을 적용할 수 있습니다. 또한 프로젝트 네트워크에 QoS 정책을 적용할 수 있습니다. 여기서 특정 정책이 연결되지 않은 포트는 정책을 상속합니다.

자세한 내용은 QoS (Quality of Service) 정책 구성을 참조하십시오.

RHOSP 프로젝트에서 생성할 수 있는 네트워크 리소스의 양을 관리합니다.

네트워킹 서비스 할당량 옵션을 사용하면 프로젝트 사용자가 생성할 수 있는 네트워크 리소스 양을 제한할 수 있습니다. 여기에는 포트, 서브넷, 네트워크 등과 같은 리소스가 포함됩니다.

자세한 내용은 프로젝트 할당량 관리를 참조하십시오.

NFV(Network Functions Virtualization)를 위해 VM 인스턴스를 최적화합니다.

인스턴스는 단일 가상 NIC를 통해 VLAN 태그가 지정된 트래픽을 보내고 받을 수 있습니다. 이 기능은 VLAN 태그가 지정된 트래픽을 예상하는 NFV 애플리케이션(VNF)에 특히 유용하므로 단일 가상 NIC가 여러 고객 또는 서비스를 제공할 수 있습니다.

VLAN 투명한 네트워크에서 VM 인스턴스에 VLAN 태그를 설정합니다. VLAN 태그는 네트워크를 통해 전송되고 동일한 VLAN의 VM 인스턴스에서 사용하며 다른 인스턴스 및 장치에서 무시됩니다. VLAN 트렁크는 VLAN을 단일 트렁크 포트에 결합하여 VLAN 인식 인스턴스를 지원합니다.

자세한 내용은 VLAN 인식 인스턴스를 참조하십시오.

인스턴스를 공유 네트워크에 연결할 수 있는 프로젝트를 제어합니다.

클라우드 관리자는 RHOSP 네트워킹 서비스에서 역할 기반 액세스 제어(RBAC) 정책을 사용하여 일부 프로젝트에서 네트워크를 생성하는 기능을 제거하고 대신 프로젝트에 해당하는 기존 네트워크에 연결할 수 있습니다.

자세한 내용은 RBAC 정책 구성을 참조하십시오.

1.2. 네트워킹 서비스 구성 요소

RHOSP(Red Hat OpenStack Platform) Networking 서비스(neutron)에는 다음 구성 요소가 포함되어 있습니다.

API 서버

RHOSP 네트워킹 API에는 계층 2 네트워킹 및 IP 주소 관리(IPAM) 지원뿐만 아니라 계층 2 네트워크와 외부 네트워크로 라우팅할 수 있는 계층 3 라우터 구성의 확장이 포함됩니다. RHOSP 네트워킹에는 라우터, 스위치, 가상 스위치, SDN(소프트웨어 정의 네트워킹) 컨트롤러를 포함한 다양한 상용 및 오픈 소스 네트워크 기술과의 상호 운용성을 지원하는 점점 증가하는 플러그인 목록이 포함되어 있습니다.

모듈형 계층 2(ML2) 플러그인 및 에이전트

ML2 플러그인 및 포트를 연결 해제하고, 네트워크 또는 서브넷을 생성하며 IP 주소 지정을 제공합니다.

메시징 대기열

에이전트 간 RPC 요청을 수락 및 라우팅하여 API 작업을 완료합니다. 메시지 큐는 Open vSwitch 및 Linux 브리지의 ML2 메커니즘 드라이버에서 각 하이퍼바이저에서 실행되는 neutron 서버와 neutron 에이전트 간 ML2 플러그인에서 사용됩니다.

1.3. 모듈형 계층 2(ML2) 네트워킹

ML2(Red Hat OpenStack Platform)는 RHOSP(Red Hat OpenStack Platform) 네트워킹 코어 플러그인입니다. ML2 모듈 설계를 사용하면 메커니즘 드라이버를 통해 혼합 네트워크 기술을 동시에 작동할 수 있습니다. OVN(Open Virtual Network)은 ML2에서 사용되는 기본 메커니즘 드라이버입니다.

ML2 프레임워크는 구성할 수 있는 두 가지 종류의 드라이버를 구분합니다.

- 드라이버 유형

RHOSP 네트워크가 기술적으로 실현되는 방법을 정의합니다.

사용 가능한 각 네트워크 유형은 ML2 유형 드라이버에서 관리하며 필요한 유형별 네트워크 상태를 유지합니다. 공급자 네트워크의 유형 관련 정보를 검증하면 유형 드라이버는 프로젝트 네트워크에서 사용 가능한 세그먼트를 할당해야 합니다. 유형 드라이버의 예로는 GENEVE, GRE, VXLAN 등이 있습니다.

- 메커니즘 드라이버

특정 유형의 RHOSP 네트워크에 액세스하는 메커니즘을 정의합니다.

메커니즘 드라이버는 유형 드라이버에 의해 설정된 정보를 가져와 활성화된 네트워킹 메커니즘에 적용합니다. 메커니즘 드라이버의 예로는 OVN(Open Virtual Networking) 및 OVS(Open vSwitch)입니다.

메커니즘 드라이버는 L2 에이전트를 사용할 수 있으며 RPC를 사용하여 외부 장치 또는 컨트롤러와 직접 상호 작용할 수 있습니다. 여러 메커니즘과 유형 드라이버를 동시에 사용하여 동일한 가상 네트워크의 다른 포트에 액세스할 수 있습니다.

1.4. ML2 네트워크 유형

여러 네트워크 세그먼트를 동시에 작동할 수 있습니다. ML2는 여러 네트워크 세그먼트의 사용 및 상호 연결을 지원합니다. ML2가 포트를 연결과 분리하기 때문에 포트를 네트워크 세그먼트에 바인딩할 필요는 없습니다. ML2는 메커니즘 드라이버에 따라 다음 네트워크 세그먼트 유형을 지원합니다.

- flat

- VLAN

- GENEVE 터널

- VXLAN 및 GRE 터널

- flat

- 모든 VM(가상 머신) 인스턴스는 동일한 네트워크에 있으며, 호스트와 공유할 수도 있습니다. VLAN 태그 지정 또는 기타 네트워크 분리가 수행되지 않습니다.

- VLAN

RHOSP 네트워킹 사용자는 물리적 네트워크에 있는 VLAN ID(802.1Q 태그)를 사용하여 여러 공급자 또는 프로젝트 네트워크를 생성할 수 있습니다. 이렇게 하면 인스턴스가 환경 전반에서 서로 통신할 수 있습니다. 또한 동일한 계층 2 VLAN의 전용 서버, 방화벽, 로드 밸런서 및 기타 네트워크 인프라와 통신할 수 있습니다.

VLAN을 사용하여 동일한 스위치에서 실행되는 컴퓨터의 네트워크 트래픽을 분할할 수 있습니다. 즉, 포트를 다른 네트워크의 구성원으로 구성하여 스위치를 논리적으로 나눌 수 있습니다. 이때 보안상의 이유로 트래픽을 분리하는 데 사용할 수 있는 미니 LAN입니다.

예를 들어 스위치에 총 24개의 포트가 있는 경우 포트 1-6을 VLAN200에 할당하고 포트 7-18을 VLAN201에 할당할 수 있습니다. 결과적으로 VLAN200에 연결된 컴퓨터는 VLAN201의 애플리케이션과 완전히 분리되며, 직접 통신할 수 없으며 원하는 경우 트래픽이 두 개의 물리적 스위치인 것처럼 라우터를 통과해야 합니다. 방화벽은 서로 통신할 수 있는 VLAN을 관리하는 데도 유용할 수 있습니다.

- GENEVE 터널

- GENEVE는 네트워크 가상화에서 변화하는 기능과 다양한 장치의 요구사항을 인식하고 수용합니다. 전체 시스템에 대해 규정되어 있지 않고 터널링을 위한 프레임워크를 제공합니다. Geneve는 캡슐화 중에 추가되는 메타데이터의 콘텐츠를 유연하게 정의하고 다양한 가상화 시나리오에 적응하려고 합니다. UDP를 전송 프로토콜로 사용하며 확장 가능한 옵션 헤더를 사용하여 크기가 동적입니다. Geneve는 유니캐스트, 멀티캐스트 및 브로드캐스트를 지원합니다. GENEVE 유형 드라이버는 ML2/OVN 메커니즘 드라이버와 호환됩니다.

- VXLAN 및 GRE 터널

- VXLAN과 GRE는 네트워크 오버레이를 사용하여 인스턴스 간 개인 통신을 지원합니다. RHOSP 네트워킹 라우터는 GRE 또는 VXLAN 프로젝트 네트워크 외부에서 트래픽을 통과하도록 트래픽을 활성화하는 데 필요합니다. 라우터는 인터넷 등 외부 네트워크를 사용하여 직접 연결된 프로젝트 네트워크를 연결해야 합니다. 라우터는 유동 IP 주소를 사용하여 외부 네트워크에서 직접 인스턴스에 연결할 수 있는 기능을 제공합니다. VXLAN 및 GRE 유형 드라이버는 ML2/OVS 메커니즘 드라이버와 호환됩니다.

1.5. 모듈형 계층 2(ML2) 메커니즘 드라이버

ML2( modular Layer 2) 플러그인은 공통 코드 베이스를 사용하는 메커니즘으로 구현됩니다. 이러한 접근 방식을 통해 코드를 재사용하고 코드 유지 관리 및 테스트와 관련된 복잡성을 없앨 수 있습니다.

Red Hat은 RHOSP 16.0부터 시작하는 모든 새로운 배포의 기본 메커니즘 드라이버로 ML2/OVN을 선택했습니다. 현재 대부분의 고객에게 ML2/OVS 메커니즘 드라이버보다 즉각적인 이점이 있기 때문입니다. 이러한 장점은 ML2/OVN 기능 세트를 계속 향상하고 개선하는 동안 각 릴리스에 대해 두 배가 증가합니다.

기존 RHOSP(Red Hat OpenStack Platform) 배포에서 ML2/OVS 메커니즘 드라이버를 사용하는 경우 OVS 드라이버를 ML2/OVN 메커니즘 드라이버로 교체하는 이점과 타당성을 평가해야 합니다. ML2 OVN Mechanism 드라이버로 네트워킹 서비스 마이그레이션 가이드를 참조하십시오.

오케스트레이션 서비스(heat) 매개변수인 NeutronMechanismDrivers 를 사용하여 메커니즘 드라이버를 활성화합니다. 다음은 heat 사용자 지정 환경 파일의 예입니다.

parameter_defaults: ... NeutronMechanismDrivers: ansible,ovn,baremetal ...

메커니즘 드라이버를 지정하는 순서는 중요합니다. 이전 예제에서 baremetal 메커니즘 드라이버를 사용하여 포트를 바인딩하려면 ansible 보다 baremetal 을 지정해야 합니다. 그렇지 않으면 NeutronMechanismDrivers 의 값 목록에서 baremetal 앞에 있기 때문에 ansible 드라이버는 포트를 바인딩합니다.

추가 리소스

- 네트워킹 서비스를 ML2 OVN Mechanism 드라이버로 마이그레이션

- Red Hat OpenStack Platform의 구성 요소, 플러그인 및 드라이버 지원의 Neutron

- Advanced Overcloud Customization 가이드의 환경 파일

- Advanced Overcloud Customization 가이드에 오버클라우드 생성에 환경 파일 포함

1.6. Open vSwitch

OVS(Open vSwitch)는 Linux 소프트웨어 브릿지와 유사한 소프트웨어 정의 네트워킹(SDN) 가상 스위치입니다. OVS는 업계 표준 OpenFlow 및 sFlow를 지원하는 가상화된 네트워크로 전환 서비스를 제공합니다. OVS는 STP, LACP 및 802.1Q VLAN 태깅과 같은 계층 2 기능을 사용하여 물리적 스위치와 통합할 수도 있습니다. Open vSwitch 버전 1.11.0-1.el6 이상에서는 VXLAN 및 GRE를 사용한 터널링도 지원합니다.

네트워크 인터페이스 본딩에 대한 자세한 내용은 Advanced Overcloud Customization 가이드의 Network Interface Bonding 가이드를 참조하십시오.

지정된 브릿지의 멤버가 될 수 있는 단일 인터페이스 또는 단일 본딩만 OVS에서 네트워크 루프 위험을 완화합니다. 여러 개의 본딩이나 인터페이스가 필요한 경우 여러 브릿지를 설정할 수 있습니다.

1.7. OVN(Open Virtual Network)

OVN(Open Virtual Network)은 가상 머신 및 컨테이너 환경에서 논리적 네트워크 추상화를 지원하는 시스템입니다. Open vSwitch용 오픈 소스 가상 네트워킹이라고 하는 OVN은 OVS의 기존 기능을 보완하여 논리 네트워크 추상화(예: 논리 L2 및 L3 오버레이, DHCP와 같은 보안 그룹 및 서비스)에 대한 기본 지원을 추가합니다.

물리적 네트워크는 물리적 전선, 스위치 및 라우터로 구성됩니다. 가상 네트워크는 물리적 네트워크를 하이퍼바이저 또는 컨테이너 플랫폼으로 확장하여 VM 또는 컨테이너를 물리적 네트워크로 브리징합니다. OVN 논리적 네트워크는 터널 또는 다른 캡슐화를 통해 물리적 네트워크에서 캡슐화된 소프트웨어로 구현된 네트워크입니다. 이를 통해 논리적 네트워크에서 사용되는 IP 및 기타 주소 공간은 충돌없이 물리적 네트워크에서 사용되는 주소와 중복될 수 있습니다. 논리적 네트워크 토폴로지는 실행하는 물리적 네트워크의 토폴로지와 관계없이 정렬할 수 있습니다. 따라서 논리적 네트워크의 일부인 VM은 네트워크 중단 없이 하나의 물리적 시스템에서 다른 시스템으로 마이그레이션할 수 있습니다.

캡슐화 계층은 논리적 네트워크에 연결된 VM과 컨테이너가 물리적 네트워크의 노드와 통신할 수 없도록 합니다. VM 및 컨테이너 클러스터링의 경우 허용 가능하거나 바람직할 수 있지만 대부분의 경우 VM과 컨테이너가 물리적 네트워크에 연결되어 있어야 합니다. OVN은 이러한 목적으로 여러 형태의 게이트웨이를 제공합니다. OVN 배포는 다음과 같은 여러 구성 요소로 구성됩니다.

- Cloud Management System (CMS)

- OVN 논리적 네트워크 요소를 관리하고 OVN 논리적 네트워크 인프라를 물리적 네트워크 요소에 연결하여 OVN을 물리적 네트워크에 통합합니다. 예를 들면 OpenStack 및 OpenShift가 있습니다.

- OVN 데이터베이스

- OVN 논리적 및 물리적 네트워크를 나타내는 데이터를 저장합니다.

- 하이퍼바이저

- Open vSwitch를 실행하고 OVN 논리적 네트워크를 실제 또는 가상 시스템의 OpenFlow로 변환합니다.

- 게이트웨이

- 터널과 물리적 네트워크 인프라 간에 패킷을 전달하여 터널 기반 OVN 논리적 네트워크를 물리적 네트워크로 확장합니다.

1.8. ML2) 모듈 계층 2 유형 및 메커니즘 드라이버 호환성

RHOSP(Red Hat OpenStack Platform) 데이터 네트워크를 계획할 때 다음 표를 참조하여 각 Modular Layer 2(ML2) 메커니즘 드라이버에서 지원하는 네트워크 유형을 확인합니다.

표 1.1. ML2 메커니즘 드라이버에서 지원하는 네트워크 유형

| 메커니즘 드라이버 | 이러한 유형의 드라이버 지원 | ||||

| flat | GRE | VLAN | VXLAN | GENEVE | |

| OVN(Open Virtual Network) | 예 | 제공되지 않음 | 예 | 예 [1] | 예 |

| OVS(Open vSwitch) | 예 | 예 | 예 | 예 | 없음 |

[1] ML2/OVN VXLAN 지원은 네트워크당 4096개의 네트워크와 4096개로 제한됩니다. 또한 Ingress 포트를 사용하는 ACL은 Ingress 포트가 전달되지 않기 때문에 ML2/OVN 및 VXLAN에서 작동하지 않습니다.

1.9. RHOSP Networking 서비스의 확장 드라이버

RHOSP(Red Hat OpenStack Platform) Networking 서비스(neutron)는 확장 가능합니다. 확장 기능은 두 가지 목적을 제공합니다. 이는 버전을 변경하지 않고도 API에서 새 기능을 도입할 수 있으며 공급 업체별 틈새 기능을 도입할 수 있습니다. 애플리케이션은 /extensions URI에서 GET을 수행하여 사용 가능한 확장을 프로그래밍 방식으로 나열할 수 있습니다. 이는 버전이 지정된 요청입니다. 즉, 하나의 API 버전에서 사용할 수 있는 확장 기능을 다른 API 버전에서 사용하지 못할 수 있습니다.

ML2 플러그인은 또한 다른 플러그형 드라이버를 통해 네트워크 개체용 ML2 플러그인에 구현된 코어 리소스를 확장할 수 있는 확장 드라이버를 지원합니다. 확장 드라이버의 예로는 QoS, 포트 보안 등에 대한 지원이 포함됩니다.

2장. ML2/OVN으로 작업

RHOSP(Red Hat OpenStack Platform) 네트워크는 Networking 서비스(neutron)에서 관리합니다. 네트워킹 서비스의 핵심은 Modular Layer 2(ML2) 플러그인이며 RHOSP ML2 플러그인의 기본 메커니즘 드라이버는 OVN(Open Virtual Networking) 메커니즘 드라이버입니다.

이전 RHOSP 버전에서는 기본적으로 OVS(Open vSwitch) 메커니즘 드라이버를 사용했지만 대부분의 배포에 대해 ML2/OVN 메커니즘 드라이버를 사용하는 것이 좋습니다.

RHOSP 13 ML2/OVS 배포에서 RHOSP 16으로 업그레이드하는 경우 업그레이드 후 ML2/OVS에서 ML2/OVN으로 마이그레이션하는 것이 좋습니다. 경우에 따라 ML2/OVN이 요구 사항을 충족하지 못할 수 있습니다. 이 경우 ML2/OVS를 사용하여 RHOSP를 배포할 수 있습니다.

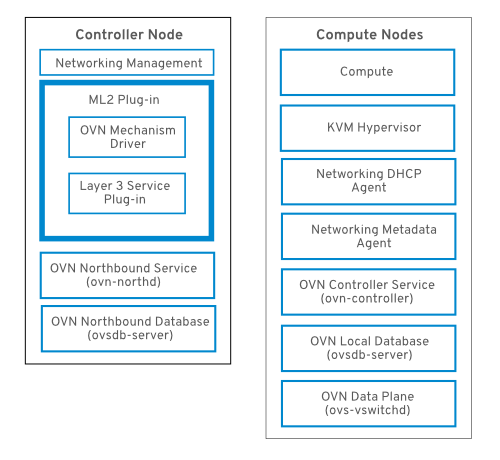

2.1. RHOSP OVN 아키텍처의 구성 요소 목록

RHOSP OVN 아키텍처는 Networking API를 지원하기 위해 OVS Modular Layer 2(ML2) 메커니즘 드라이버를 OVN ML2 메커니즘 드라이버로 대체합니다. OVN은 Red Hat OpenStack 플랫폼을 위한 네트워킹 서비스를 제공합니다.

OVN 아키텍처는 다음 구성 요소 및 서비스로 구성됩니다.

- OVN 메커니즘 드라이버를 사용한 ML2 플러그인

- ML2 플러그인은 OpenStack 관련 네트워킹 구성을 플랫폼 중립 OVN 논리적 네트워킹 구성으로 변환합니다. 일반적으로 컨트롤러 노드에서 실행됩니다.

- OVN Northbound(NB) 데이터베이스(

ovn-nb) -

이 데이터베이스는 OVN ML2 플러그인의 논리적 OVN 네트워킹 구성을 저장합니다. 일반적으로 컨트롤러 노드에서 실행되며 TCP 포트

6641에서 수신 대기합니다. - OVN Northbound 서비스(

ovn-northd) - 이 서비스는 논리적 네트워킹 구성을 OVN NB 데이터베이스에서 논리 데이터 경로 흐름으로 변환하고 OVN Southbound 데이터베이스에서 이러한 구성을 채웁니다. 일반적으로 컨트롤러 노드에서 실행됩니다.

- OVN Southbound(SB) 데이터베이스(

ovn-sb) -

이 데이터베이스는 변환된 논리적 데이터 경로 흐름을 저장합니다. 일반적으로 컨트롤러 노드에서 실행되며 TCP 포트

6642에서 수신 대기합니다. - OVN 컨트롤러(

ovn-controller) -

이 컨트롤러는 OVN SB 데이터베이스에 연결하고 네트워크 트래픽을 제어 및 모니터링하기 위해 open vSwitch 컨트롤러 역할을 합니다.

OS::Tripleo::Services::OVNController가 정의된 모든 Compute 및 게이트웨이 노드에서 실행됩니다. - OVN 메타데이터 에이전트(

ovn-metadata-agent) -

이 에이전트는 메타데이터 API 요청을 프록시하는 데 사용되는 OVS 인터페이스, 네트워크 네임스페이스 및 HAProxy 프로세스를 관리하기 위한

haproxy인스턴스를 생성합니다. 에이전트는OS::TripleO::Services::OVNMetadataAgent가 정의된 모든 컴퓨팅 및 게이트웨이 노드에서 실행됩니다. - OVSDB(OVSDB)

-

OVN Northbound 및 Southbound 데이터베이스를 호스팅합니다. 또한

ovs-vswitchd와 상호 작용하여 OVS 데이터베이스conf.db를 호스트합니다.

NB 데이터베이스의 스키마 파일은 /usr/share/ovn/ovn-nb.ovsschema 에 있으며 SB 데이터베이스 스키마 파일은 /usr/share/ovn/ovn-sb.ovsschema 에 있습니다.

2.2. ML2/OVN 데이터베이스

Red Hat OpenStack Platform ML2/OVN 배포에서 네트워크 구성 정보는 공유 분산 데이터베이스를 통해 프로세스 간에 전달됩니다. 이러한 데이터베이스를 검사하여 네트워크 상태를 확인하고 문제를 확인할 수 있습니다.

- OVN northbound 데이터베이스

northbound 데이터베이스(

OVN_Northbound)는 OVN과 RHOSP(Red Hat OpenStack Platform)와 같은 클라우드 관리 시스템 간의 인터페이스 역할을 합니다. RHOSP는 northbound 데이터베이스의 콘텐츠를 생성합니다.northbound 데이터베이스에는 현재 원하는 네트워크 상태가 포함되어 있으며 논리 포트, 논리 스위치, 논리 라우터 등의 컬렉션으로 표시됩니다. 모든 RHOSP Networking 서비스(neutron) 오브젝트는 northbound 데이터베이스의 테이블에 표시됩니다.

- OVN southbound 데이터베이스

-

southbound 데이터베이스(

OVN_Southbound)에는 OVN 시스템의 논리적 및 물리적 구성 상태가 가상 네트워크 추상화를 지원합니다.ovn-controller는 이 데이터베이스의 정보를 사용하여 네트워킹 서비스(neutron) 요구 사항을 충족하기 위해 OVS를 구성합니다.

2.3. 컴퓨팅 노드의 ovn-controller 서비스

ovn-controller 서비스는 각 Compute 노드에서 실행되며 OVN southbound(SB) 데이터베이스 서버에 연결하여 논리 흐름을 검색합니다. ovn-controller 는 이러한 논리 흐름을 물리적 OpenFlow 흐름으로 변환하고 OVS 브리지(br-int)에 흐름을 추가합니다. ovs-vswitchd 와 통신하고 OpenFlow 흐름을 설치하기 위해 ovn-controller 는 ovn-controller 가 시작될 때 전달된 UNIX 소켓 경로를 사용하여 로컬 ovsdb-server (예: unix:/var/run/openvswitch/db.sock.sock )에 연결됩니다.

ovn-controller 서비스는 Open_vSwitch 테이블의 external_ids 열에 있는 특정 키-값 쌍을 예상합니다. puppet-ovn 은 puppet-vswitch 를 사용하여 이러한 필드를 채웁니다. 다음 예제에서는 puppet-vswitch 가 external_ids 열에서 구성하는 키-값 쌍을 보여줍니다.

hostname=<HOST NAME> ovn-encap-ip=<IP OF THE NODE> ovn-encap-type=geneve ovn-remote=tcp:OVN_DBS_VIP:6642

2.4. 컴퓨팅 노드의 OVN 메타데이터 에이전트

OVN 메타데이터 에이전트는 tripleo-heat-templates/ovn/ovn-metadata-container-puppet.yaml 파일에 구성되며 OS::TripleO::Services::OVNMetadataAgent 를 통해 기본 Compute 역할에 포함됩니다. 따라서 기본 매개 변수가 있는 OVN 메타데이터 에이전트는 OVN 배포의 일부로 배포됩니다.

OpenStack 게스트 인스턴스는 링크-로컬 IP 주소에서 사용 가능한 네트워킹 메타데이터 서비스에 액세스합니다. 169.254.169.254. neutron-ovn-metadata-agent 는 Compute 메타데이터 API가 존재하는 호스트 네트워크에 액세스할 수 있습니다. 각 HAProxy는 적절한 호스트 네트워크에 연결할 수 없는 네트워크 네임스페이스에 있습니다. HAProxy는 필요한 헤더를 메타데이터 API 요청에 추가한 다음, UNIX 도메인 소켓을 통해 neutron-ovn-metadata-agent 에 요청을 전달합니다.

OVN 네트워킹 서비스는 메타데이터 서비스를 활성화하는 각 가상 네트워크에 대해 고유한 네트워크 네임스페이스를 생성합니다. 컴퓨팅 노드의 인스턴스에서 액세스하는 각 네트워크에는 해당 메타데이터 네임스페이스(ovnmeta-<network_uuid>)가 있습니다.

2.5. OVN 구성 가능 서비스

Red Hat OpenStack Platform은 일반적으로 컨트롤러 역할, Compute 역할 및 다양한 스토리지 역할 유형의 노드와 같이 사전 정의된 역할의 노드로 구성됩니다. 이러한 각 기본 역할에는 코어 heat 템플릿 컬렉션에 정의된 서비스 세트가 포함되어 있습니다.

기본 RHOSP(Red Hat OpenStack) 배포에서 ML2/OVN 구성 가능 서비스가 컨트롤러 노드에서 실행됩니다. 선택적으로 사용자 지정 Networker 역할을 생성하고 전용 Networker 노드에서 OVN 구성 가능 서비스를 실행할 수 있습니다.

OVN 구성 가능 서비스 ovn-dbs 는 ovn-dbs-bundle이라는 컨테이너에 배포됩니다. 기본 설치 ovn-dbs 는 컨트롤러 역할에 포함되어 컨트롤러 노드에서 실행됩니다. 서비스는 구성 가능이므로 Networker 역할과 같은 다른 역할에 할당할 수 있습니다.

OVN 구성 가능 서비스를 다른 역할에 할당하는 경우 서비스가 pacemaker 서비스와 동일한 노드에 배치되어 OVN 데이터베이스 컨테이너를 제어합니다.

2.6. OVN을 사용한 계층 3 고가용성

OVN은 특별한 구성없이 레이어 3 HA(고가용성)를 지원합니다. OVN은 지정된 외부 네트워크에서 L3 게이트웨이 역할을 할 수 있는 사용 가능한 모든 게이트웨이 노드에 라우터 포트를 자동으로 예약합니다. OVN L3 HA는 OVN Logical_Router_Port 테이블의 gateway_chassis 열을 사용합니다. 대부분의 기능은 함께 제공되는 active_passive 출력이 있는 OpenFlow 규칙에 의해 관리됩니다. ovn-controller 는 ARP(Address Resolution Protocol) 응답자 및 라우터 활성화 및 비활성화를 처리합니다. FIP 및 라우터 외부 주소에 대한 Gratuitous ARP도 ovn-controller 에서 정기적으로 보냅니다.

L3HA는 OVN을 사용하여 라우터를 원래 게이트웨이 노드로 다시 분산하여 노드가 병목 현상이 발생하지 않도록 합니다.

BFD 모니터링

OVN은 BFD(Bidirectional Forwarding Detection) 프로토콜을 사용하여 게이트웨이 노드의 가용성을 모니터링합니다. 이 프로토콜은 노드에서 노드로 설정된 Geneve 터널을 기반으로 캡슐화됩니다.

각 게이트웨이 노드는 배포의 별 토폴로지에 있는 다른 모든 게이트웨이 노드를 모니터링합니다. 또한 게이트웨이 노드는 계산 노드를 모니터링하여 게이트웨이가 패킷 및 ARP 응답 및 알림의 라우팅을 활성화 및 비활성화할 수 있도록 합니다.

각 컴퓨팅 노드는 BFD를 사용하여 각 게이트웨이 노드를 모니터링하고 지정된 라우터에 대한 활성 게이트웨이 노드를 통해 SNAT(Source and destination Network Address Translation)와 같은 외부 트래픽을 자동으로 수행합니다. 컴퓨팅 노드는 다른 compute 노드를 모니터링할 필요가 없습니다.

ML2-OVS 구성에서는 외부 네트워크 오류가 감지되지 않습니다.

OVN용 L3 HA는 다음과 같은 실패 모드를 지원합니다.

- 게이트웨이 노드는 네트워크에서 연결이 끊어집니다(터널링 인터페이스).

-

OVS-vswitchd중지 (ovs-switchd는 BFD 신호를 담당합니다) -

OVN-controller가 중지됨(ovn-controller가 등록된 노드로 제거됨).

이 BFD 모니터링 메커니즘은 라우팅 실패가 아니라 링크 실패에서만 작동합니다.

2.7. ML2/OVN 메커니즘 드라이버의 제한 사항

ML2/OVS 메커니즘 드라이버에서 사용할 수 있는 일부 기능은 ML2/OVN 메커니즘 드라이버에서 아직 지원되지 않습니다.

2.7.1. ML2/OVN에서 아직 지원하지 않는 ML2/OVS 기능

| 기능 | 참고 | 이 기능 추적 |

|---|---|---|

| VLAN 프로젝트(테넌트) 네트워크에서 OVN을 사용하는 배포된 가상 라우팅(DVR). | FIP 트래픽은 ML2/OVN 및 DVR을 사용하여 VLAN 테넌트 네트워크에 전달하지 않습니다. DVR은 새로운 ML2/OVN 배포 및 DVR이 활성화된 ML2/OVS 배포에서 마이그레이션된 ML2/OVN 배포에서 기본적으로 활성화됩니다. OVN을 사용하여 VLAN 테넌트 네트워크가 필요한 경우 DVR을 비활성화할 수 있습니다. DVR을 비활성화하려면 환경 파일에 다음 행을 포함합니다. parameter_defaults: NeutronEnableDVR: false | https://bugzilla.redhat.com/show_bug.cgi?id=1704596https://bugzilla.redhat.com/show_bug.cgi?id=1766930 |

| OVN DHCP를 사용하여 베어 메탈 머신 프로비저닝 |

현재 OVN의 기본 제공 DHCP 서버는 베어 메탈 노드를 프로비저닝할 수 없습니다. 프로비저닝 네트워크에 DHCP를 제공할 수 없습니다. 체인부팅 iPXE에는 OVN DHCP 서버에서 지원되지 않는 태그 지정( dnsmasq의 |

2.7.2. 핵심 OVN 제한 사항

외부 포트가 논리 라우터의 게이트웨이 포트와 함께 배치되지 않으므로 VLAN 테넌트 네트워크의 VF(direct) 포트의 North/south 라우팅은 SR-IOV에서 작동하지 않습니다. https://bugs.launchpad.net/neutron/+bug/1875852 참조하십시오.

2.8. ML2/OVN을 사용하는 비보안 포트 제한

기본 ML2/OVN 메커니즘 드라이버와 많은 수의 포트를 사용하여 RHOSP(Red Hat Open Stack Platform) 배포에서 포트 보안 플러그인 확장을 비활성화하면 포트에 연결할 수 없습니다.

일부 대규모 ML2/OVN RHSOP 배포에서 ML2/OVN 내부의 흐름 체인 제한은 보안 플러그인이 비활성화된 포트를 대상으로 하는 ARP 요청을 삭제할 수 있습니다.

ML2/OVN에서 지원할 수 있는 실제 논리 스위치 포트 수에 대한 문서화된 최대 제한은 없지만 limit approximateskubelet 포트입니다.

대략적인 제한에 기여하는 속성은 ML2/OVN이 생성하는 OpenFlow 파이프라인에서 다시 제출한 수이며 전체 논리 토폴로지를 변경합니다.

2.9. ML2/OVS에서 ML2/OVN 내부 마이그레이션으로 마이그레이션: 검증 및 금지된 시나리오

Red Hat은 지속적인 내부 마이그레이션 시나리오를 테스트하고 세부적으로 조정합니다. Red Hat 기술 계정 관리자 또는 글로벌 전문가 서비스와 협력하여 OVS 배포가 올바른 즉각적 마이그레이션 시나리오의 기준을 충족하는지 확인합니다.

2.9.1. ML2/OVS에서 ML2/OVN 마이그레이션 시나리오로 검증

- DVR로 DVR

시작: DVR을 사용하는 OVS를 사용한 RHOSP 16.1.1 이상

종료일: DVR을 통한 OVN과 동일한 RHOSP 버전 및 릴리스.

SR-IOV는 시작 환경에 존재하지 않거나 마이그레이션 중 또는 마이그레이션 후에 추가되었습니다.

- VF(가상 기능) 포트가 있는 SR-IOV의 중앙 집중식 라우팅 + SR-IOV만 사용

시작: OVS를 사용한 RHOSP 16.1.1 이상( DVR 없음) 및 SR-IOV.

종료일: OVN( DVR 없음) 및 SR-IOV와 동일한 RHOSP 버전 및 릴리스.

워크로드는 SR-IOV VF(가상 기능) 포트만 사용했습니다. SR-IOV 물리적 기능(PF) 포트로 마이그레이션에 실패했습니다.

2.9.2. ML2/OVS에서 ML2/OVN 내부 마이그레이션 시나리오로 확인되지 않았습니다.

Red Hat에서 기본 문제가 해결되었음을 발표할 때까지 다음 시나리오에서는 내부 ML2/OVS를 ML2/OVN으로 마이그레이션할 수 없습니다.

- OVS 배포에서는 VXLAN, 대상 배포 RHOSP 16.2.0을 사용합니다.

RHOSP는 아직 VXLAN 네트워크에서 ML2/OVN을 지원하지 않습니다. 마이그레이션 프로세스에는 VXLAN 네트워크를 Geneve로 변환하는 단계가 포함됩니다. 마이그레이션 대상 버전이 RHOSP 16.2.0인 경우 버그로 인해 예상 VXLAN을 Geneve로 변환할 수 없으며 네트워크는 VXLAN으로 구성됩니다. See https://bugzilla.redhat.com/show_bug.cgi?id=2003708.

이 버그는 RHOSP 16.2에서 ML2/OVN으로의 마이그레이션에만 영향을 미칩니다.

- OVS 배포에서는 NFV(네트워크 기능 가상화)를 사용합니다.

- Red Hat은 ML2/OVN 및 NFV를 사용한 새로운 배포를 지원하지만 ML2/OVS 및 NFV 배포의 ML2/OVN으로의 마이그레이션을 성공적으로 테스트하지 않았습니다. 이 문제의 진행 상황을 추적하려면 https://bugzilla.redhat.com/show_bug.cgi?id=1925290 을 참조하십시오.

- PPF(물리적 기능) 포트가 있는 SR-IOV

- 워크로드에서 SR-IOV PF 포트를 사용하는 경우 마이그레이션 테스트에 실패했습니다. 이 문제의 진행 상황을 추적하려면 https://bugzilla.redhat.com/show_bug.cgi?id=1879546 을 참조하십시오.

- OVS에서 트렁크 포트 사용

- ML2/OVS 배포에서 트렁크 포트를 사용하는 경우 ML2/OVN 마이그레이션에 ML2/OVS를 수행하지 마십시오. 마이그레이션이 OVN 환경에 트렁크된 포트를 올바르게 설정하지 않습니다. 이 문제의 진행 상황을 추적하려면 https://bugzilla.redhat.com/show_bug.cgi?id=1857652 을 참조하십시오.

- DVR(VLAN 프로젝트(테넌트) 네트워크 포함)

- DVR 및 VLAN 프로젝트 네트워크를 사용하여 ML2/OVN으로 마이그레이션하지 마십시오. 중앙 집중식 라우팅을 통해 ML2/OVN으로 마이그레이션할 수 있습니다. 이 문제의 진행 상황을 추적하려면 https://bugzilla.redhat.com/show_bug.cgi?id=1766930 을 참조하십시오.

2.9.3. ML2/OVS에서 ML2/OVN 내부 마이그레이션 및 보안 그룹 규칙으로

원래 ML2/OVS 배포의 사용자 지정 보안 그룹 규칙이 대상 ML2/OVN 배포와 호환되는지 확인합니다.

예를 들어 default 보안 그룹에는 DHCP 서버로의 송신을 허용하는 규칙이 포함됩니다. ML2/OVS 배포에서 이러한 규칙을 삭제한 경우 ML2/OVS는 자동으로 DHCP 서버에 송신을 허용하는 암시적 규칙을 추가합니다. 이러한 암시적 규칙은 ML2/OVN에서 지원되지 않으므로 대상 ML2/OVN 환경에서 DHCP 및 메타데이터 트래픽이 DHCP 서버에 도달하지 않고 인스턴스가 부팅되지 않습니다. 이 경우 DHCP 액세스를 복원하려면 다음 규칙을 추가할 수 있습니다.

# Allow VM to contact dhcp server (ipv4)

openstack security group rule create --egress --ethertype IPv4 --protocol udp --dst-port 67 ${SEC_GROUP_ID}

# Allow VM to contact metadata server (ipv4)

openstack security group rule create --egress --ethertype IPv4 --protocol tcp --remote-ip 169.254.169.254 ${SEC_GROUP_ID}

# Allow VM to contact dhcp server (ipv6, non-slaac). Be aware that the remote-ip may vary depending on your use case!

openstack security group rule create --egress --ethertype IPv6 --protocol udp --dst-port 547 --remote-ip ff02::1:2 ${SEC_GROUP_ID}

# Allow VM to contact metadata server (ipv6)

openstack security group rule create --egress --ethertype IPv6 --protocol tcp --remote-ip fe80::a9fe:a9fe ${SEC_GROUP_ID}2.10. 새 RHOSP 16.2 배포에서 기본 ML2/OVN 대신 ML2/OVS 사용

RHOSP(Red Hat OpenStack Platform) 16.0 이상 배포에서 ML2/OVN(Open Virtual Network)을 사용한 Modular Layer 2 플러그인은 RHOSP Networking 서비스의 기본 메커니즘 드라이버입니다. 애플리케이션에 ML2/OVS 메커니즘 드라이버가 필요한 경우 이 설정을 변경할 수 있습니다.

절차

-

stack사용자로 언더클라우드에 로그인합니다. 템플릿 파일

/home/stack/templates/containers-prepare-parameter.yaml에서ovn대신neutron_driver매개 변수 값으로ovs을 사용합니다.parameter_defaults: ContainerImagePrepare: - set: ... neutron_driver: ovs환경 파일에서

/usr/share/openstack-tripleo-heat-templates/environments/services/neutron-ovs.yaml에서NeutronNetworkType매개변수에 originalve대신 ScanSetting또는gre가 포함되어 있는지 확인합니다.예제

parameter_defaults: ... NeutronNetworkType: 'vxlan'

openstack overcloud deploy명령을 실행하고 수정한 코어 heat 템플릿, 환경 파일 및 파일을 포함합니다.중요후속 환경 파일에 정의된 매개 변수와 리소스가 우선하기 때문에 환경 파일의 순서가 중요합니다.

$ openstack overcloud deploy --templates \ -e <your_environment_files> \ -e /usr/share/openstack-tripleo-heat-templates/environments/services/ \ neutron-ovs.yaml \ -e /home/stack/templates/containers-prepare-parameter.yaml \

추가 리소스

- Advanced Overcloud Customization 가이드의 환경 파일

- Advanced Overcloud Customization 가이드에 오버클라우드 생성에 환경 파일 포함

2.11. 기본 ML2/OVN 대신 업그레이드 후 ML2/OVS 유지

RHOSP(Red Hat OpenStack Platform) 16.0 이상 배포에서 ML2/OVN(Open Virtual Network)을 사용한 Modular Layer 2 플러그인은 RHOSP Networking 서비스의 기본 메커니즘 드라이버입니다. ML2/OVS를 사용한 이전 버전의 RHOSP에서 업그레이드하는 경우 업그레이드 후 ML2/OVN에서 ML2/OVS로 마이그레이션할 수 있습니다.

업그레이드 후 ML2/OVS를 계속 사용하려면 문서화된 Red Hat의 업그레이드 절차에 따라 ML2/OVS-to-ML2/OVN 마이그레이션을 수행하지 마십시오.

2.12. ML2/OVN으로 사용자 정의 역할 배포

기본 RHOSP(Red Hat OpenStack) 배포에서 ML2/OVN 구성 가능 서비스가 컨트롤러 노드에서 실행됩니다. 다음 예에 설명된 것과 같이 지원되는 사용자 지정 역할을 선택적으로 사용할 수 있습니다.

- Networker

- 전용 네트워크 노드에서 OVN 구성 가능 서비스를 실행합니다.

- SR-IOV로 Networker

- SR-IOV를 사용하여 전용 네트워크 관리자 노드에서 OVN 구성 가능 서비스를 실행합니다.

- SR-IOV가 있는 컨트롤러

- SR-IOV 가능 컨트롤러 노드에서 OVN 구성 가능 서비스를 실행합니다.

자체 사용자 지정 역할을 생성할 수도 있습니다.

제한

다음 제한 사항은 이 릴리스에서 ML2/OVN 및 기본 OVN DHCP를 사용한 SR-IOV 사용에 적용됩니다.

- 모든 외부 포트는 모든 포트에 HA 섀시 그룹이 하나뿐이므로 단일 게이트웨이 노드에서 예약됩니다.

- 외부 포트가 논리 라우터의 게이트웨이 포트와 함께 배치되지 않으므로 VLAN 테넌트 네트워크의 VF(direct) 포트의 North/south 라우팅은 SR-IOV에서 작동하지 않습니다. https://bugs.launchpad.net/neutron/+bug/1875852 참조하십시오.

사전 요구 사항

- 사용자 지정 역할을 배포하는 방법을 알고 있습니다. 자세한 내용은 Advanced Overcloud Customization 가이드의 Composable services and custom roles 를 참조하십시오.

절차

언더클라우드 호스트에

stack사용자로 로그인하고stackrc파일을 소싱합니다.$ source stackrc

배포에 적합한 사용자 지정 역할 파일을 선택합니다. 필요에 따라 배포 명령에 직접 사용합니다. 또는 다른 사용자 지정 역할 파일을 결합하는 사용자 지정 역할 파일을 생성할 수 있습니다.

Deployment Role 역할 파일 Networker 역할

Networker

Networker.yamlSR-IOV를 통한 Networker 역할

NetworkerSriov

NetworkerSriov.yamlSR-IOV를 사용한 공동 배치 제어 및 네트워크

ControllerSriov

ControllerSriov.yaml- [선택 사항] 이러한 사용자 지정 역할 파일 중 하나를 다른 사용자 지정 역할 파일과 결합하는 새 사용자 지정 역할 데이터 파일을 생성합니다. Advanced Overcloud Customization 가이드의 roles_data 파일 생성에 있는 지침을 따르십시오. 배포에 따라 적절한 소스 역할 파일을 포함합니다.

- [선택 사항] 역할의 특정 노드를 식별하기 위해 특정 하드웨어 플레이버를 생성하고 특정 노드에 플레이버를 할당할 수 있습니다. 그런 다음 환경 파일을 사용하여 역할의 플레이버를 정의하고 노드 수를 지정합니다. 자세한 내용은 Advanced Overcloud Customization 가이드의 새 역할 생성 예제를 참조하십시오.

배포에 적합한 환경 파일을 만듭니다.

Deployment 샘플 환경 파일 Networker 역할

neutron-ovn-dvr-ha.yaml

SR-IOV를 통한 Networker 역할

ovn-sriov.yaml

배포에 적합한 다음 설정을 포함합니다.

Deployment 설정 Networker 역할

ControllerParameters: OVNCMSOptions: "" ControllerSriovParameters: OVNCMSOptions: "" NetworkerParameters: OVNCMSOptions: "enable-chassis-as-gw" NetworkerSriovParameters: OVNCMSOptions: ""SR-IOV를 통한 Networker 역할

OS::TripleO::Services::NeutronDhcpAgent: OS::Heat::None ControllerParameters: OVNCMSOptions: "" ControllerSriovParameters: OVNCMSOptions: "" NetworkerParameters: OVNCMSOptions: "" NetworkerSriovParameters: OVNCMSOptions: "enable-chassis-as-gw"SR-IOV를 사용한 공동 배치 제어 및 네트워크

OS::TripleO::Services::NeutronDhcpAgent: OS::Heat::None ControllerParameters: OVNCMSOptions: "" ControllerSriovParameters: OVNCMSOptions: "enable-chassis-as-gw" NetworkerParameters: OVNCMSOptions: "" NetworkerSriovParameters: OVNCMSOptions: ""-

오버클라우드를 배포합니다.

-e옵션을 사용하여 배포 명령에 환경 파일을 포함합니다. r 옵션을 사용하여 배포 명령에 사용자 지정 역할 데이터 파일을 포함합니다. 예:-r Networker.yaml또는-r mycustomrolesfile.yaml.

검증 단계 - OVN 배포

기본적으로

heat-admin인 오버클라우드 SSH 사용자로 컨트롤러 또는 네트워크 노드에 로그인합니다.예제

ssh heat-admin@controller-0

Controller 및 Networker 노드에서

ovn_metadata_agent가 실행 중인지 확인합니다.$ sudo podman ps | grep ovn_metadata

샘플 출력

a65125d9588d undercloud-0.ctlplane.localdomain:8787/rh-osbs/rhosp16-openstack-neutron-metadata-agent-ovn:16.2_20200813.1 kolla_start 23 hours ago Up 21 hours ago ovn_metadata_agent

OVN 서비스 또는 전용 네트워크 노드가 있는 컨트롤러 노드가 OVS의 게이트웨이로 구성되어 있는지 확인합니다.

$ sudo ovs-vsctl get Open_Vswitch . external_ids:ovn-cms-options

샘플 출력

... enable-chassis-as-gw ...

검증 단계 - SR-IOV 배포

기본적으로

heat-admin인 오버클라우드 SSH 사용자로 컴퓨팅 노드에 로그인합니다.예제

ssh heat-admin@compute-0

neutron_sriov_agent가 컴퓨팅 노드에서 실행 중인지 확인합니다.$ sudo podman ps | grep neutron_sriov_agent

샘플 출력

f54cbbf4523a undercloud-0.ctlplane.localdomain:8787/rh-osbs/rhosp16-openstack-neutron-sriov-agent:16.2_20200813.1 kolla_start 23 hours ago Up 21 hours ago neutron_sriov_agent

네트워크 사용 SR-IOV NIC가 성공적으로 감지되었는지 확인합니다.

$ sudo podman exec -uroot galera-bundle-podman-0 mysql nova -e 'select hypervisor_hostname,pci_stats from compute_nodes;'

샘플 출력

computesriov-1.localdomain {... {"dev_type": "type-PF", "physical_network": "datacentre", "trusted": "true"}, "count": 1}, ... {"dev_type": "type-VF", "physical_network": "datacentre", "trusted": "true", "parent_ifname": "enp7s0f3"}, "count": 5}, ...} computesriov-0.localdomain {... {"dev_type": "type-PF", "physical_network": "datacentre", "trusted": "true"}, "count": 1}, ... {"dev_type": "type-VF", "physical_network": "datacentre", "trusted": "true", "parent_ifname": "enp7s0f3"}, "count": 5}, ...}

추가 리소스

- Advanced Overcloud Customization 가이드의 구성 가능 서비스 및 사용자 지정 역할.

2.13. ML2/OVN 및 기본 OVN DHCP가 있는 SR-IOV

사용자 지정 역할을 배포하여 기본 OVN DHCP를 사용하여 ML2/OVN 배포에서 SR-IOV를 사용할 수 있습니다. 2.12절. “ML2/OVN으로 사용자 정의 역할 배포”을 참조하십시오.

제한

다음 제한 사항은 이 릴리스에서 ML2/OVN 및 기본 OVN DHCP를 사용한 SR-IOV 사용에 적용됩니다.

- 모든 외부 포트는 모든 포트에 HA 섀시 그룹이 하나뿐이므로 단일 게이트웨이 노드에서 예약됩니다.

- 외부 포트가 논리 라우터의 게이트웨이 포트와 함께 배치되지 않으므로 VLAN 테넌트 네트워크의 VF(direct) 포트의 North/south 라우팅은 SR-IOV에서 작동하지 않습니다. https://bugs.launchpad.net/neutron/+bug/1875852 참조하십시오.

추가 리소스

- Advanced Overcloud Customization 가이드의 구성 가능 서비스 및 사용자 지정 역할.

3장. 프로젝트 네트워크 관리

프로젝트 네트워크는 클라우드 컴퓨팅의 네트워크 트래픽을 격리하는 데 도움이 됩니다. 프로젝트 네트워크를 생성하는 단계에는 네트워크 계획 및 생성, 서브넷 및 라우터 추가가 포함됩니다.

3.1. VLAN 계획

Red Hat OpenStack Platform 배포를 계획할 때 개별 IP 주소를 할당하는 여러 서브넷으로 시작합니다. 여러 서브넷을 사용하는 경우 시스템 간에 트래픽을 VLAN으로 분리할 수 있습니다.

예를 들어 관리 또는 API 트래픽이 웹 트래픽을 제공하는 시스템과 동일한 네트워크에 있지 않은 것이 이상적입니다. VLAN 간 트래픽은 트래픽 흐름을 제어하는 방화벽을 구현할 수 있는 라우터를 통해 이동합니다.

배포 시 다양한 유형의 가상 네트워킹 리소스에 대한 트래픽 격리, 고가용성 및 IP 주소 사용률을 포함하는 전체 계획의 일부로 VLAN을 계획해야 합니다.

단일 네트워크의 최대 VLAN 수 또는 네트워크 노드에 대한 하나의 OVS 에이전트는 4094입니다. 최대 VLAN 수가 필요한 경우 여러 개의 프로바이더 네트워크(VXLAN 네트워크)와 네트워크당 하나씩 여러 네트워크 노드를 생성할 수 있습니다. 각 노드에는 최대 4094개의 사설 네트워크를 포함할 수 있습니다.

3.2. 네트워크 트래픽 유형

호스팅하려는 다양한 네트워크 트래픽 유형에 별도의 VLAN을 할당할 수 있습니다. 예를 들어 이러한 각 네트워크 유형에 대해 별도의 VLAN이 있을 수 있습니다. 외부 네트워크만 외부 물리적 네트워크로 라우팅할 수 있어야 합니다. 이번 릴리스에서 director는 DHCP 서비스를 제공합니다.

모든 OpenStack 배포에 대해 이 섹션의 모든 격리된 VLAN이 필요하지 않습니다. 예를 들어, 클라우드 사용자가 필요에 따라 임시 가상 네트워크를 생성하지 않으면 프로젝트 네트워크가 필요하지 않을 수 있습니다. 각 VM이 다른 물리적 시스템과 동일한 스위치에 직접 연결하려면 Compute 노드를 공급자 네트워크에 직접 연결하고 해당 프로바이더 네트워크를 직접 사용하도록 인스턴스를 구성합니다.

- 프로비저닝 네트워크 - 이 VLAN은 PXE 부팅을 통해 director를 사용하여 새 노드를 배포하는 전용입니다. OpenStack Orchestration(heat)은 Overcloud 베어 메탈 서버에 OpenStack을 설치합니다. 이러한 서버는 실제 네트워크에 연결하여 Undercloud 인프라에서 플랫폼 설치 이미지를 받습니다.

내부 API 네트워크 - OpenStack 서비스는 API 통신, RPC 메시지 및 데이터베이스 통신을 포함하여 내부 API 네트워크를 사용하여 통신할 수 있습니다. 또한 이 네트워크는 컨트롤러 노드 간 작동 메시지에도 사용됩니다. IP 주소 할당을 계획할 때 각 API 서비스에 고유한 IP 주소가 필요합니다. 특히 다음 각 서비스에 대한 IP 주소를 계획해야 합니다.

- vip-msg (ampq)

- vip-keystone-int

- av-glance-int

- vip-cinder-int

- vip-nova-int

- vip-neutron-int

- vip-horizon-int

- vip-heat-int

- vip-ceilometer-int

- vip-swift-int

- vip-keystone-pub

- vip-glance-pub

- vip-cinder-pub

- vip-nova-pub

- vip-neutron-pub

- vip-horizon-pub

- vip-heat-pub

- vip-ceilometer-pub

- vip-swift-pub

고가용성을 사용하는 경우 Pacemaker는 물리 노드 간에 VIP 주소를 이동합니다.

- 스토리지 - 블록 스토리지, NFS, iSCSI 및 기타 스토리지 서비스. 성능상의 이유로 이 네트워크를 분리하여 물리적 이더넷 링크를 분리합니다.

- 스토리지 관리 - OpenStack Object Storage(swift)는 이 네트워크를 사용하여 참여한 복제본 노드 간에 데이터 오브젝트를 동기화합니다. 프록시 서비스는 사용자 요청과 기본 스토리지 계층 간의 중간 인터페이스 역할을 합니다. 프록시는 들어오는 요청을 수신하고 요청된 데이터를 검색하는 데 필요한 복제본을 찾습니다. Ceph 백엔드를 사용하는 서비스는 Ceph와 직접 상호 작용하지 않고 프론트엔드 서비스를 사용하는 스토리지 관리 네트워크를 통해 연결됩니다. RBD 드라이버는 예외입니다. 이 트래픽은 Ceph에 직접 연결됩니다.

- 프로젝트 네트워크 - Neutron은 VLAN 분리(각 프로젝트 네트워크가 네트워크 VLAN인) 또는 VXLAN 또는 GRE를 사용하여 터널링을 사용하여 각 프로젝트에 자체 네트워크를 제공합니다. 각 프로젝트 네트워크 내에서 네트워크 트래픽이 격리됩니다. 각 프로젝트 네트워크에는 연결된 IP 서브넷이 있으며, 여러 프로젝트 네트워크에서 동일한 주소를 사용할 수 있습니다.

- external - 외부 네트워크는 공용 API 엔드포인트 및 대시보드(horizon)에 대한 연결을 호스팅합니다. SNAT에 이 네트워크를 사용할 수도 있습니다. 프로덕션 배포에서는 일반적으로 유동 IP 주소와 NAT에 별도의 네트워크를 사용하는 것이 일반적입니다.

- 프로바이더 네트워크 - 프로바이더 네트워크를 사용하여 인스턴스를 기존 네트워크 인프라에 연결합니다. 프로바이더 네트워크를 사용하면 플랫 네트워킹 또는 VLAN 태그를 사용하여 데이터 센터의 기존 실제 네트워크에 직접 매핑할 수 있습니다. 이렇게 하면 인스턴스에서 OpenStack Networking 인프라 외부에 있는 시스템과 동일한 계층-2 네트워크를 공유할 수 있습니다.

3.3. IP 주소 사용

다음 시스템은 할당된 범위의 IP 주소를 사용합니다.

- 물리 노드 - 각 물리적 NIC에는 하나의 IP 주소가 필요합니다. 물리적 NIC를 특정 기능에 전용으로 지정하는 것이 일반적입니다. 예를 들어, 관리 및 NFS 트래픽을 별도의 물리적 NIC에 할당하고, 중복을 위해 여러 NIC를 서로 다른 스위치에 연결하는 경우가 있습니다.

- 고가용성을 위한 VIP(가상 IP) - 컨트롤러 노드가 공유하는 각 네트워크에 대해 VIP를 1~3개에 할당할 계획입니다.

3.4. 가상 네트워킹

다음 가상 리소스는 OpenStack Networking에서 IP 주소를 사용합니다. 이러한 리소스는 클라우드 인프라로 로컬로 간주되며 외부 물리적 네트워크의 시스템에서 연결할 필요가 없습니다.

- 프로젝트 네트워크 - 각 프로젝트 네트워크에 IP 주소를 인스턴스에 할당하는 데 사용할 수 있는 서브넷이 필요합니다.

- 가상 라우터 - 서브넷에 연결하는 각 라우터 인터페이스에는 하나의 IP 주소가 필요합니다. DHCP를 사용하려면 각 라우터 인터페이스에 두 개의 IP 주소가 필요합니다.

- 인스턴스 - 각 인스턴스에는 인스턴스를 호스팅하는 프로젝트 서브넷의 주소가 필요합니다. 인그레스 트래픽이 필요한 경우 지정된 외부 네트워크에서 인스턴스에 유동 IP 주소를 할당해야 합니다.

- 관리 트래픽 - OpenStack 서비스 및 API 트래픽이 포함됩니다. 모든 서비스는 적은 수의 VIP를 공유합니다. API, RPC 및 데이터베이스 서비스는 내부 API VIP에서 통신합니다.

3.5. 네트워크 라우팅 추가

새 네트워크에서 트래픽 라우팅을 허용하려면 서브넷을 기존 가상 라우터에 인터페이스로 추가해야 합니다.

- 대시보드에서 프로젝트 > 네트워크 > 라우터 를 선택합니다.

Routers (라우터) 목록에서 가상 라우터 이름을 선택하고 Add Interface(인터페이스 추가 )를 클릭합니다.

Subnet(서브넷) 목록에서 새 서브넷의 이름을 선택합니다. 이 필드의 인터페이스에 대한 IP 주소를 선택적으로 지정할 수 있습니다.

Add Interface (인터페이스 추가)를 클릭합니다.

이제 네트워크의 인스턴스가 서브넷 외부의 시스템과 통신할 수 있습니다.

3.6. 네트워크 계획 예

이 예에서는 각 서브넷이 다양한 IP 주소가 할당되는 여러 서브넷을 수용하는 여러 네트워크를 보여줍니다.

표 3.1. 서브넷 계획 예

| 서브넷 이름 | 주소 범위 | 주소 수 | 서브넷 마스크 |

|---|---|---|---|

| 프로비저닝 네트워크 | 192.168.100.1 - 192.168.100.250 | 250 | 255.255.255.0 |

| 내부 API 네트워크 | 172.16.1.10 - 172.16.1.250 | 241 | 255.255.255.0 |

| 스토리지 | 172.16.2.10 - 172.16.2.250 | 241 | 255.255.255.0 |

| 스토리지 관리 | 172.16.3.10 - 172.16.3.250 | 241 | 255.255.255.0 |

| 테넌트 네트워크(GRE/VXLAN) | 172.16.4.10 - 172.16.4.250 | 241 | 255.255.255.0 |

| 외부 네트워크(유동 IP 포함) | 10.1.2.10 - 10.1.3.222 | 469 | 255.255.254.0 |

| 공급자 네트워크(인프라) | 10.10.3.10 - 10.10.3.250 | 241 | 255.255.252.0 |

3.7. 네트워크 생성

인스턴스가 서로 통신하고 DHCP를 사용하여 IP 주소를 수신할 수 있도록 네트워크를 만듭니다. 외부 네트워크 연결에 대한 자세한 내용은 물리적 네트워크 브리징을 참조하십시오.

네트워크를 만들 때 네트워크에서 여러 서브넷을 호스팅할 수 있다는 것을 알아야 합니다. 이 기능은 동일한 네트워크에서 서로 다른 시스템을 호스팅하고 시스템 간의 격리 측정값을 선호하는 경우에 유용합니다. 예를 들어 한 서브넷에 웹 서버 트래픽만 있는 반면 데이터베이스 트래픽은 다른 서브넷을 트래버스하도록 지정할 수 있습니다. 서브넷은 서로 격리되며 다른 서브넷과 통신하려는 인스턴스에는 라우터에서 보내는 트래픽이 있어야 합니다. 라우팅이 필요하지 않도록 동일한 서브넷에 많은 트래픽이 필요한 시스템을 배치하고 후속 대기 시간과 부하를 피할 수 있습니다.

- 대시보드에서 프로젝트 > 네트워크 > 네트워크를 선택합니다.

+Create Network (+네트워크 만들기)를 클릭하고 다음 값을 지정합니다.

필드 설명 네트워크 이름

네트워크에서 수행할 역할에 따라 설명적인 이름입니다. 네트워크를 외부 VLAN과 통합하는 경우 VLAN ID 번호를 이름에 추가하는 것이 좋습니다. 예를 들어,

webservers_122에서 이 서브넷에서 HTTP 웹 서버를 호스팅하는 경우 VLAN 태그가122입니다. 또는 네트워크 트래픽을 비공개로 유지하고 네트워크를 외부 네트워크와 통합하지 않으려는경우 internal전용을 사용할 수 있습니다.관리 상태

네트워크를 즉시 사용할 수 있는지 여부를 제어합니다. 이 필드를 사용하여 논리적으로 존재하지만 비활성 상태인 Down 상태의 네트워크를 생성합니다. 이 기능은 네트워크를 즉시 프로덕션에 입력하려는 경우 유용합니다.

서브넷 만들기

서브넷을 만들지 여부를 결정합니다. 예를 들어 이 네트워크를 네트워크 연결 없이 자리 표시자로 유지하려는 경우 서브넷을 생성하지 않을 수 있습니다.

Next 단추를 클릭하고 Subnet( 서브넷) 탭에서 다음 값을 지정합니다.

필드 설명 서브넷 이름

서브넷의 설명이 포함된 이름을 입력합니다.

네트워크 주소

IP 주소 범위와 서브넷 마스크가 포함된 CIDR 형식으로 주소를 하나의 값으로 입력합니다. 주소를 확인하려면 서브넷 마스크에 마스킹된 비트 수를 계산하고 해당 값을 IP 주소 범위에 추가합니다. 예를 들어 서브넷 마스크 255.255.255.0에는 24개의 마스킹된 비트가 있습니다. IPv4 주소 범위 192.168.122.0으로 이 마스크를 사용하려면 주소 192.168.122.0/24를 지정합니다.

IP 버전

유효한 유형이 IPv4 또는 IPv6인 인터넷 프로토콜 버전을 지정합니다. Network Address(네트워크 주소) 필드의 IP 주소 범위는 선택한 모든 버전과 일치해야 합니다.

게이트웨이 IP

기본 게이트웨이에 대한 라우터 인터페이스의 IP 주소입니다. 이 주소는 외부 위치로 향하는 트래픽을 라우팅하기 위한 다음 홉이며, 네트워크 주소 필드에 지정하는 범위 내에 있어야 합니다. 예를 들어 CIDR 네트워크 주소가 192.168.122.0/24인 경우 기본 게이트웨이는 192.168.122.1일 수 있습니다.

게이트웨이 비활성화

는 전달을 비활성화하고 서브넷을 격리합니다.

다음을 클릭하여 DHCP 옵션을 지정합니다.

- DHCP 활성화 - 이 서브넷에 DHCP 서비스를 활성화합니다. DHCP를 사용하여 인스턴스에 대한 IP 설정을 자동으로 배포할 수 있습니다.

IPv6 주소 - 구성 모드. IPv6 네트워크를 생성하는 경우 IPv6 주소 및 추가 정보를 할당하는 방법을 지정해야 합니다.

- 지정된 옵션 없음 - IP 주소를 수동으로 설정하거나 주소 할당에 OpenStack을 인식하지 않는 방법을 사용하려면 이 옵션을 선택합니다.

- SLAAC(상태 비저장 주소 자동 구성) - 인스턴스에서 OpenStack Networking 라우터에서 보낸 R(라우터 알림) 메시지를 기반으로 IPv6 주소를 생성합니다. 이 구성을 사용하여 ra_mode가 slaac로 설정된 OpenStack Networking 서브넷을 만들고 address_mode를 slaac로 설정합니다.

- DHCPv6 상태 저장 - 인스턴스에서 IPv6 주소 및 OpenStack Networking DHCPv6 서비스에서 추가 옵션(예: DNS)을 수신합니다. 이 구성을 사용하여 ra_mode가 dhcpv6-stateful로 설정되어 있고 address_mode가 dhcpv6-stateful로 설정된 서브넷을 생성합니다.

- DHCPv6 상태 비저장 - 인스턴스에서 OpenStack Networking 라우터에서 전송된 라우터 알림(RA) 메시지를 기반으로 IPv6 주소를 생성합니다. 추가 옵션(예: DNS)은 OpenStack Networking DHCPv6 서비스에서 할당됩니다. 이 구성을 사용하여 ra_mode가 dhcpv6-stateless로 설정된 서브넷을 만들고 address_mode를 dhcpv6-stateless로 설정합니다.

- 할당 풀 - DHCP가 할당할 IP 주소 범위입니다. 예를 들어 192.168.22.100,192.168.22.150 값은 해당 범위의 모든 주소를 할당에 사용할 수 있는 것으로 간주합니다.

DNS 이름 서버 - 네트워크에서 사용할 수 있는 DNS 서버의 IP 주소입니다. DHCP는 이름 확인을 위해 이러한 주소를 인스턴스에 배포합니다.

중요DNS와 같은 전략적 서비스의 경우 클라우드에 호스팅하지 않는 것이 좋습니다. 예를 들어, 클라우드 호스트 DNS와 클라우드가 작동할 수 없게 되면 DNS를 사용할 수 없으며 클라우드 구성 요소는 서로 조회를 수행할 수 없습니다.

- 호스트 경로 - 정적 호스트 경로. 먼저 CIDR 형식의 대상 네트워크를 지정한 다음 라우팅에 사용할 다음 홉을 지정합니다(예: 192.168.23.0/24, 10.1.31.1). 정적 경로를 인스턴스에 배포해야 하는 경우 이 값을 제공합니다.

생성을 클릭합니다.

Networks(네트워크 ) 탭에서 전체 네트워크를 볼 수 있습니다. 필요에 따라 Edit(편집 )를 클릭하여 옵션을 변경할 수도 있습니다. 인스턴스를 만들 때 서브넷을 사용하도록 이제 구성할 수 있으며 지정된 DHCP 옵션이 제공됩니다.

3.8. 서브넷 작업

서브넷을 사용하여 인스턴스에 네트워크 연결 권한을 부여합니다. 각 인스턴스는 인스턴스 생성 프로세스의 일부로 서브넷에 할당되므로 연결 요구 사항을 가장 잘 수용할 수 있도록 인스턴스를 적절하게 배치하는 것이 중요합니다.

기존 네트워크에서만 서브넷을 만들 수 있습니다. OpenStack Networking의 프로젝트 네트워크는 여러 서브넷을 호스팅할 수 있습니다. 이 기능은 동일한 네트워크에서 서로 다른 시스템을 호스팅하고 시스템 간의 격리 측정값을 선호하는 경우에 유용합니다.

예를 들어 하나의 서브넷에 웹 서버 트래픽만 있는 반면 데이터베이스 트래픽은 다른 서브넷을 트래버스하도록 지정할 수 있습니다.

서브넷은 서로 격리되며 다른 서브넷과 통신하려는 인스턴스에는 라우터에서 보내는 트래픽이 있어야 합니다. 따라서 서로 많은 트래픽이 필요한 동일한 서브넷에서 시스템을 그룹화하여 네트워크 대기 시간을 줄이고 부하를 줄일 수 있습니다.

3.9. 서브넷 생성

서브넷을 만들려면 다음 단계를 따르십시오.

- 대시보드에서 Project > Network > Networks(네트워크 > 네트워크 ) 를 선택하고 Networks( 네트워크 ) 보기에서 네트워크 이름을 클릭합니다.

Create Subnet(서브넷 만들기) 을 클릭하고 다음 값을 지정합니다.

필드 설명 서브넷 이름

설명이 포함된 서브넷 이름.

네트워크 주소

IP 주소 범위와 서브넷 마스크를 하나의 값으로 포함하는 CIDR 형식의 주소입니다. CIDR 주소를 확인하려면 서브넷 마스크에 마스킹된 비트 수를 계산하고 해당 값을 IP 주소 범위에 추가합니다. 예를 들어 서브넷 마스크 255.255.255.0에는 24개의 마스킹된 비트가 있습니다. IPv4 주소 범위 192.168.122.0으로 이 마스크를 사용하려면 주소 192.168.122.0/24를 지정합니다.

IP 버전

인터넷 프로토콜 버전입니다. 여기서 유효한 유형은 IPv4 또는 IPv6입니다. Network Address(네트워크 주소) 필드의 IP 주소 범위는 선택한 모든 프로토콜 버전과 일치해야 합니다.

게이트웨이 IP

기본 게이트웨이에 대한 라우터 인터페이스의 IP 주소입니다. 이 주소는 외부 위치로 향하는 트래픽을 라우팅하기 위한 다음 홉이며, 네트워크 주소 필드에 지정하는 범위 내에 있어야 합니다. 예를 들어 CIDR 네트워크 주소가 192.168.122.0/24인 경우 기본 게이트웨이는 192.168.122.1일 수 있습니다.

게이트웨이 비활성화

는 전달을 비활성화하고 서브넷을 격리합니다.

다음을 클릭하여 DHCP 옵션을 지정합니다.

- DHCP 활성화 - 이 서브넷에 DHCP 서비스를 활성화합니다. DHCP를 사용하여 인스턴스에 대한 IP 설정을 자동으로 배포할 수 있습니다.

IPv6 주소 - 구성 모드. IPv6 네트워크를 생성하는 경우 IPv6 주소 및 추가 정보를 할당하는 방법을 지정해야 합니다.

- 지정된 옵션 없음 - IP 주소를 수동으로 설정하거나 주소 할당에 OpenStack을 인식하지 않는 방법을 사용하려면 이 옵션을 선택합니다.

- SLAAC(상태 비저장 주소 자동 구성) - 인스턴스에서 OpenStack Networking 라우터에서 보낸 R(라우터 알림) 메시지를 기반으로 IPv6 주소를 생성합니다. 이 구성을 사용하여 ra_mode가 slaac로 설정된 OpenStack Networking 서브넷을 만들고 address_mode를 slaac로 설정합니다.

- DHCPv6 상태 저장 - 인스턴스에서 IPv6 주소 및 OpenStack Networking DHCPv6 서비스에서 추가 옵션(예: DNS)을 수신합니다. 이 구성을 사용하여 ra_mode가 dhcpv6-stateful로 설정되어 있고 address_mode가 dhcpv6-stateful로 설정된 서브넷을 생성합니다.

- DHCPv6 상태 비저장 - 인스턴스에서 OpenStack Networking 라우터에서 전송된 라우터 알림(RA) 메시지를 기반으로 IPv6 주소를 생성합니다. 추가 옵션(예: DNS)은 OpenStack Networking DHCPv6 서비스에서 할당됩니다. 이 구성을 사용하여 ra_mode가 dhcpv6-stateless로 설정된 서브넷을 만들고 address_mode를 dhcpv6-stateless로 설정합니다.

- 할당 풀 - DHCP가 할당할 IP 주소 범위입니다. 예를 들어 192.168.22.100,192.168.22.150 값은 해당 범위의 모든 주소를 할당에 사용할 수 있는 것으로 간주합니다.

- DNS 이름 서버 - 네트워크에서 사용할 수 있는 DNS 서버의 IP 주소입니다. DHCP는 이름 확인을 위해 이러한 주소를 인스턴스에 배포합니다.

- 호스트 경로 - 정적 호스트 경로. 먼저 CIDR 형식의 대상 네트워크를 지정한 다음 라우팅에 사용할 다음 홉을 지정합니다(예: 192.168.23.0/24, 10.1.31.1). 정적 경로를 인스턴스에 배포해야 하는 경우 이 값을 제공합니다.

생성을 클릭합니다.

Subnets(서브넷) 목록에서 서브넷을 볼 수 있습니다. 필요에 따라 Edit(편집 )를 클릭하여 옵션을 변경할 수도 있습니다. 인스턴스를 만들 때 서브넷을 사용하도록 이제 구성할 수 있으며 지정된 DHCP 옵션이 제공됩니다.

3.10. 라우터 추가

OpenStack Networking은 SDN 기반 가상 라우터를 사용하여 라우팅 서비스를 제공합니다. 라우터는 인스턴스가 실제 네트워크의 서브넷을 포함하여 외부 서브넷과 통신하기 위해 필요합니다. 라우터 및 서브넷은 인터페이스를 사용하여 연결되며, 각 서브넷에는 자체 인터페이스가 필요한 라우터가 있습니다.

라우터의 기본 게이트웨이는 라우터에서 수신한 모든 트래픽의 다음 홉을 정의합니다. 해당 네트워크는 일반적으로 가상 브리지를 사용하여 트래픽을 외부 물리적 네트워크로 라우팅하도록 구성됩니다.

라우터를 생성하려면 다음 단계를 완료합니다.

- 대시보드에서 프로젝트 > 네트워크 > 라우터를 선택하고 Create Router(라우터 만들기 )를 클릭합니다.

- 새 라우터의 설명이 포함된 이름을 입력하고 Create router(라우터 만들기 )를 클릭합니다.

- Routers (라우터) 목록에서 새 라우터의 항목 옆에 있는 Set Gateway (게이트웨이 설정)를 클릭합니다.

- External Network (외부 네트워크) 목록에서 외부 위치로 향하는 트래픽을 수신하려는 네트워크를 지정합니다.

Set Gateway (게이트웨이 설정)를 클릭합니다.

라우터를 추가한 후 이 라우터를 사용하여 트래픽을 보내도록 만든 서브넷을 구성해야 합니다. 서브넷과 라우터 간에 인터페이스를 만들어 이 작업을 수행합니다.

서브넷의 기본 경로를 덮어쓸 수 없습니다. 서브넷의 기본 경로가 제거되면 L3 에이전트에서 라우터 네임스페이스의 해당 경로도 자동으로 제거하며 네트워크 트래픽이 연결된 서브넷으로 또는 연결된 서브넷에서 이동할 수 없습니다. 기존 라우터 네임스페이스 경로가 제거된 경우 이 문제를 해결하려면 다음 단계를 수행하십시오.

- 서브넷의 모든 유동 IP의 연결을 끊습니다.

- 서브넷에서 라우터를 분리합니다.

- 라우터를 서브넷에 다시 연결합니다.

- 모든 유동 IP를 다시 연결합니다.

3.11. 모든 리소스 제거 및 프로젝트 삭제

openstack project purge 명령을 사용하여 특정 프로젝트에 속하는 모든 리소스와 프로젝트 삭제도 삭제합니다.

예를 들어 test-project 프로젝트의 리소스를 제거한 다음 프로젝트를 삭제하려면 다음 명령을 실행합니다.

# openstack project list +----------------------------------+--------------+ | ID | Name | +----------------------------------+--------------+ | 02e501908c5b438dbc73536c10c9aac0 | test-project | | 519e6344f82e4c079c8e2eabb690023b | services | | 80bf5732752a41128e612fe615c886c6 | demo | | 98a2f53c20ce4d50a40dac4a38016c69 | admin | +----------------------------------+--------------+ # openstack project purge --project 02e501908c5b438dbc73536c10c9aac0

3.12. 라우터 삭제

연결된 인터페이스가 없는 경우 라우터를 삭제할 수 있습니다.

인터페이스를 제거하고 라우터를 삭제하려면 다음 단계를 완료합니다.

- 대시보드에서 프로젝트 > 네트워크 > 라우터 를 선택하고 삭제하려는 라우터 이름을 클릭합니다.

- 내부 인터페이스 유형의 인터페이스를 선택하고 Delete Interfaces(인터페이스 삭제 )를 클릭합니다.

- Routers(라우터) 목록에서 대상 라우터를 선택하고 Delete Routers(라우터 삭제 )를 클릭합니다.

3.13. 서브넷 삭제

서브넷이 더 이상 사용되지 않는 경우 삭제할 수 있습니다. 그러나 서브넷을 사용하도록 인스턴스가 여전히 구성된 경우 삭제 시도가 실패하고 대시보드에 오류 메시지가 표시됩니다.

네트워크에서 특정 서브넷을 삭제하려면 다음 단계를 완료합니다.

- 대시보드에서 프로젝트 > 네트워크 > 네트워크를 선택합니다.

- 네트워크 이름을 클릭합니다.

- 대상 서브넷을 선택하고 Delete Subnets(서브넷 삭제 )를 클릭합니다.

3.14. 네트워크 삭제

하우스키핑 또는 폐기 프로세스의 일부로 이전에 만든 네트워크를 삭제해야 하는 경우가 있습니다. 먼저 네트워크를 성공적으로 삭제하기 전에 네트워크가 아직 사용 중인 인터페이스를 제거하거나 분리해야 합니다.

프로젝트의 네트워크를 종속 인터페이스와 함께 삭제하려면 다음 단계를 완료합니다.

대시보드에서 프로젝트 > 네트워크 > 네트워크를 선택합니다.

대상 네트워크 서브넷과 연결된 모든 라우터 인터페이스를 제거합니다.

인터페이스를 제거하려면 Networks (네트워크) 목록에서 대상 네트워크를 클릭하고 ID 필드를 확인하여 삭제할 네트워크의 ID 번호를 찾습니다. 네트워크와 연결된 모든 서브넷은 네트워크 ID 필드에서 이 값을 공유합니다.

Project(프로젝트) > Network > Routers (네트워크 > 라우터) 로 이동하여 Routers (라우터) 목록에서 가상 라우터 이름을 클릭하고 삭제하려는 서브넷에 연결된 인터페이스를 찾습니다.

게이트웨이 IP로 제공되는 IP 주소로 이 서브넷을 다른 서브넷과 구분할 수 있습니다. 인터페이스의 네트워크 ID가 이전 단계에서 기록한 ID와 일치하는지 확인하여 차이점을 추가로 확인할 수 있습니다.

- 삭제할 인터페이스에 대해 Delete Interface (인터페이스 삭제) 단추를 클릭합니다.

- 프로젝트 > 네트워크 > 네트워크를 선택하고 네트워크 이름을 클릭합니다.

삭제할 서브넷의 Delete Subnet(서브넷 삭제) 단추를 클릭합니다.

참고이때 서브넷을 제거할 수 없는 경우 인스턴스에서 서브넷을 아직 사용하지 않는지 확인합니다.

- 프로젝트 > 네트워크 > 네트워크를 선택하고 삭제하려는 네트워크를 선택합니다.

- Delete Networks(네트워크 삭제)를 클릭합니다.

4장. VM 인스턴스를 물리적 네트워크에 연결

플랫 및 VLAN 공급자 네트워크를 사용하여 VM 인스턴스를 외부 네트워크에 직접 연결할 수 있습니다.

4.1. OpenStack Networking 토폴로지 개요

OpenStack Networking(neutron)에는 여러 노드 유형에 분산된 두 가지 서비스 범주가 있습니다.

- Neutron 서버 - 이 서비스는 OpenStack Networking API 서버와 상호 작용하는 최종 사용자 및 서비스에 API를 제공하는 OpenStack Networking API 서버를 실행합니다. 또한 이 서버는 기본 데이터베이스와 통합되어 프로젝트 네트워크, 라우터 및 로드 밸런서 세부 정보를 저장하고 검색합니다.

Neutron 에이전트 - OpenStack 네트워킹의 네트워크 기능을 수행하는 서비스입니다.

-

neutron-dhcp-agent- 프로젝트 사설 네트워크의 DHCP IP 주소 지정을 관리합니다. -

neutron-l3-agent- 프로젝트 사설 네트워크, 외부 네트워크 등의 계층 3 라우팅을 수행합니다.

-

-

계산 노드 - 이 노드는 가상 머신(인스턴스라고도 함)을 실행하는 하이퍼바이저를 호스팅합니다. 인스턴스에 외부 연결을 제공하려면 컴퓨팅 노드를 네트워크에 직접 연결해야 합니다. 일반적으로 이 노드는

neutron-openvswitch-agent와 같이 l2 에이전트가 실행되는 위치입니다.

4.2. OpenStack Networking 서비스 배치

OpenStack Networking 서비스는 동일한 물리적 서버에서 또는 해당 역할에 따라 이름이 지정된 별도의 전용 서버에서 함께 실행할 수 있습니다.

- Controller node(컨트롤러 노드 ) - API 서비스를 실행하는 서버입니다.

- 네트워크 노드 - OpenStack Networking 에이전트를 실행하는 서버입니다.

- 계산 노드 - 인스턴스를 호스팅하는 하이퍼바이저 서버입니다.

이 장의 단계는 이러한 세 가지 노드 유형을 포함하는 환경에 적용됩니다. 배포에 동일한 물리 노드에 컨트롤러 및 네트워크 노드 역할이 모두 있는 경우 해당 서버의 두 섹션에서 단계를 수행해야 합니다. 세 개의 노드 모두 컨트롤러 노드와 HA를 사용하여 네트워크 노드 서비스를 실행할 수 있는 HA(고가용성) 환경에도 적용됩니다. 결과적으로 세 노드 모두에서 컨트롤러 및 네트워크 노드에 적용되는 섹션의 단계를 완료해야 합니다.

4.3. 플랫 공급자 네트워크 구성

플랫 프로바이더 네트워크를 사용하여 인스턴스를 외부 네트워크에 직접 연결할 수 있습니다. 이 기능은 여러 개의 실제 네트워크와 개별 실제 인터페이스가 있고 각 Compute 및 Network 노드를 이러한 외부 네트워크에 연결하려는 경우 유용합니다.

사전 요구 사항

물리적 네트워크가 여러 개 있습니다.

이 예에서는 각각

physnet1 및라는 물리적 네트워크를 사용합니다.physnet2별도의 물리적 인터페이스가 있습니다.

이 예에서는 각각 별도의 실제 인터페이스인

eth0및eth1을 사용합니다.

절차

Undercloud 호스트에서 stack 사용자로 로그인한 사용자 지정 YAML 환경 파일을 만듭니다.

예제

$ vi /home/stack/templates/my-modules-environment.yaml

작은 정보Red Hat OpenStack Platform Orchestration 서비스(heat)는 templates 라는 플랜 세트를 사용하여 환경을 설치하고 구성합니다. 오케스트레이션 템플릿에 대한 사용자 지정을 제공하는 특수 유형의 템플릿 파일인 사용자 지정 환경 파일을 사용하여 오버클라우드의 특정 부분을 사용자 지정할 수 있습니다.

parameters

_defaults의 YAML 환경 파일에서NeutronBridgeMappings를 사용하여 외부 네트워크에 액세스하는 데 사용할 OVS 브리지를 지정합니다.예제

parameter_defaults: NeutronBridgeMappings: 'physnet1:br-net1,physnet2:br-net2'

컨트롤러 및 컴퓨팅 노드의 사용자 지정 NIC 구성 템플릿에서 연결된 인터페이스를 사용하여 브리지를 구성합니다.

예제

... - type: ovs_bridge name: br-net1 mtu: 1500 use_dhcp: false members: - type: interface name: eth0 mtu: 1500 use_dhcp: false primary: true - type: ovs_bridge name: br-net2 mtu: 1500 use_dhcp: false members: - type: interface name: eth1 mtu: 1500 use_dhcp: false primary: true ...openstack overcloud deploy명령을 실행하고 수정된 이 사용자 지정 NIC 템플릿과 새 환경 파일을 포함하여 템플릿과 환경 파일을 포함합니다.중요후속 환경 파일에 정의된 매개 변수와 리소스가 우선하기 때문에 환경 파일의 순서가 중요합니다.

예제

$ openstack overcloud deploy --templates \ -e [your-environment-files] \ -e /usr/share/openstack-tripleo-heat-templates/environments/services/my-neutron-environment.yaml

검증

외부 네트워크(

public1)를 플랫 네트워크로만들어 구성된 물리적 네트워크(physnet1)와 연결합니다.다른 사용자가 외부 네트워크에 직접 연결하는 VM 인스턴스를 생성하도록 공유 네트워크(

--share사용)로 구성합니다.예제

# openstack network create --share --provider-network-type flat --provider-physical-network physnet1 --external public01

openstack subnet create명령을 사용하여 서브넷(public_subnet)을 만듭니다.예제

# openstack subnet create --no-dhcp --allocation-pool start=192.168.100.20,end=192.168.100.100 --gateway 192.168.100.1 --network public01 public_subnet

VM 인스턴스를 만들고 새로 생성된 외부 네트워크에 직접 연결합니다.

예제

$ openstack server create --image rhel --flavor my_flavor --network public01 my_instance

추가 리소스

- Advanced Overcloud Customization 가이드의 사용자 지정 네트워크 인터페이스 템플릿

- Advanced Overcloud Customization 가이드의 환경 파일

- Advanced Overcloud Customization 가이드에 오버클라우드 생성에 환경 파일 포함

- 명령줄 인터페이스 참조에서 네트워크 생성

- 명령줄 인터페이스 참조에서 서브넷 생성

- 명령줄 인터페이스 참조에서 서버 생성

4.4. 플랫 프로바이더 네트워크 패킷 흐름은 어떻게 작동합니까?

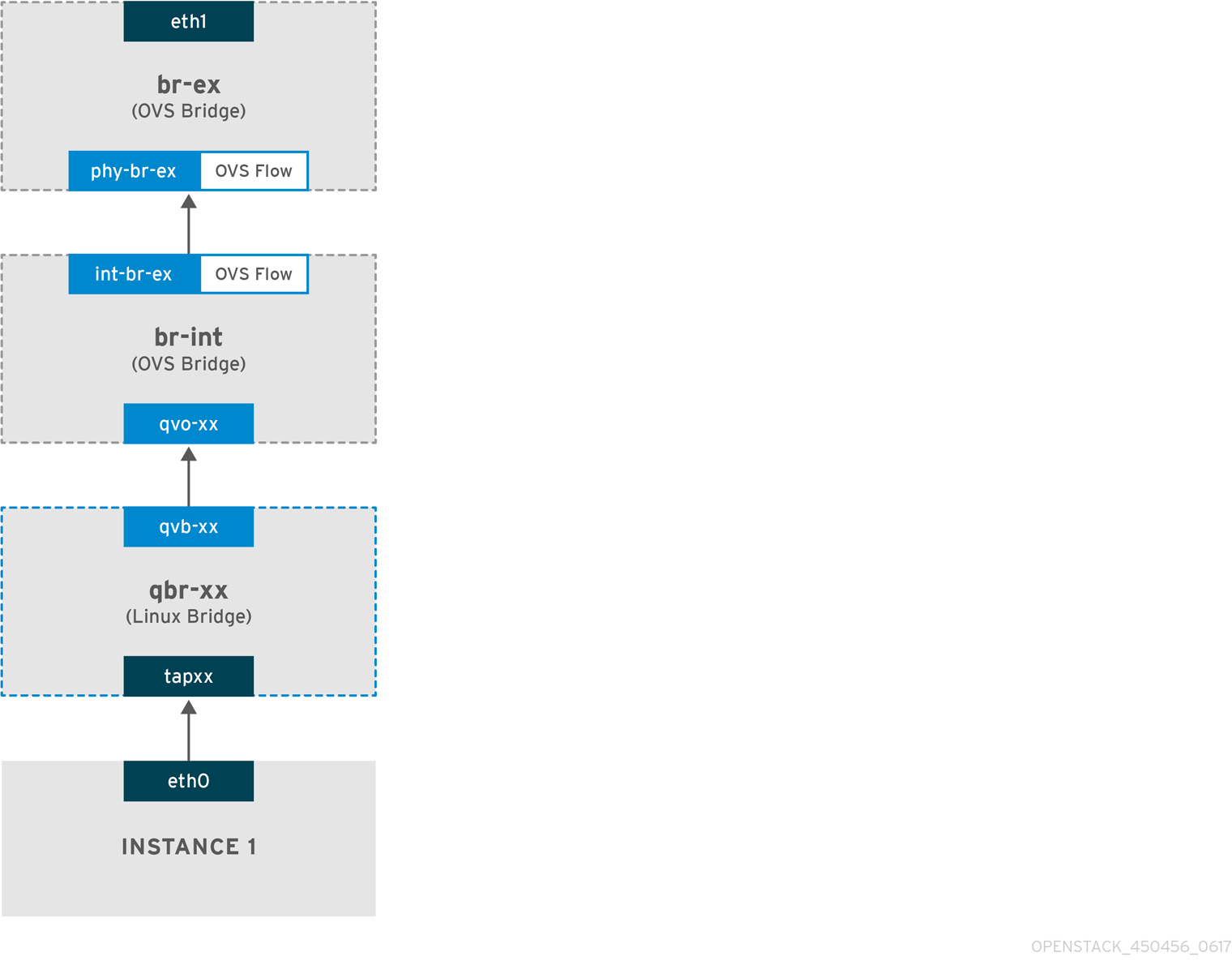

이 섹션에서는 플랫 프로바이더 네트워크 구성이 있는 인스턴스와의 트래픽 흐름 방법을 자세히 설명합니다.

플랫 공급자 네트워크에서 나가는 트래픽 흐름

다음 다이어그램에서는 인스턴스를 벗어나고 외부 네트워크에 직접 도착하는 트래픽의 패킷 흐름을 설명합니다. br-ex 외부 브리지를 구성한 후 실제 인터페이스를 브리지에 추가하고 Compute 노드에 인스턴스를 생성합니다. 결과적으로 생성된 인터페이스 및 브리지 구성은 다음 다이어그램의 구성과 비슷합니다( iptables_hybrid 방화벽 드라이버를 사용하는 경우).

-

패킷은 인스턴스의

eth0인터페이스를 종료하고 Linux 브리지qbr-xx에 도착합니다. -

브리지

qbr-xx는 veth 쌍qvb에 연결됩니다. 이는 브리지가 보안 그룹에서 정의한 인바운드/아웃바운드 방화벽 규칙을 적용하는 데 사용되기 때문입니다.-xx <-> qvo-xxx를 사용하여 br-int -

qvb-xx인터페이스는qbr-xxlinux 브리지에 연결되고qvoxx는br-intOpen vSwitch(OVS) 브리지에 연결됩니다.

'qbr-xx'Linux 브리지의 구성 예:

# brctl show qbr269d4d73-e7 8000.061943266ebb no qvb269d4d73-e7 tap269d4d73-e7

br-int의 구성 :qvo- xx

# ovs-vsctl show

Bridge br-int

fail_mode: secure

Interface "qvof63599ba-8f"

Port "qvo269d4d73-e7"

tag: 5

Interface "qvo269d4d73-e7"

포트 qvo-xx 는 flat 프로바이더 네트워크와 연결된 내부 VLAN 태그로 태그가 지정됩니다. 이 예에서 VLAN 태그는 5 입니다. 패킷이 qvo-xx 에 도달하면 VLAN 태그가 패킷 헤더에 추가됩니다.

그런 다음 patch-peer int OVS 브리지로 이동합니다.

-br-ex <-> phy-br-ex를 사용하여 패킷이 br -ex

br-int 의 patch-peer 구성 예 :

# ovs-vsctl show

Bridge br-int

fail_mode: secure

Port int-br-ex

Interface int-br-ex

type: patch

options: {peer=phy-br-ex}

br-ex 의 patch-peer 구성 예 :

Bridge br-ex

Port phy-br-ex

Interface phy-br-ex

type: patch

options: {peer=int-br-ex}

Port br-ex

Interface br-ex

type: internal

이 패킷이 br 에 도달하면 -ex의 phy-br -exbr-ex 내부의 OVS 흐름이 VLAN 태그를 제거하고 실제 인터페이스로 전달합니다.

다음 예에서 출력에는 phy-br-ex 의 포트 번호가 2 가 표시되어 있습니다.

# ovs-ofctl show br-ex

OFPT_FEATURES_REPLY (xid=0x2): dpid:00003440b5c90dc6

n_tables:254, n_buffers:256

capabilities: FLOW_STATS TABLE_STATS PORT_STATS QUEUE_STATS ARP_MATCH_IP

actions: OUTPUT SET_VLAN_VID SET_VLAN_PCP STRIP_VLAN SET_DL_SRC SET_DL_DST SET_NW_SRC SET_NW_DST SET_NW_TOS SET_TP_SRC SET_TP_DST ENQUEUE

2(phy-br-ex): addr:ba:b5:7b:ae:5c:a2

config: 0

state: 0

speed: 0 Mbps now, 0 Mbps max

다음 출력은 VLAN 태그가 5 (dl_vlan=5)인 phy-br-ex (in_port=2)에 도착하는 모든 패킷을 보여줍니다. 또한 br-ex의 OVS 흐름은 VLAN 태그를 제거하고 패킷을 실제 인터페이스로 전달합니다.

# ovs-ofctl dump-flows br-ex NXST_FLOW reply (xid=0x4): cookie=0x0, duration=4703.491s, table=0, n_packets=3620, n_bytes=333744, idle_age=0, priority=1 actions=NORMAL cookie=0x0, duration=3890.038s, table=0, n_packets=13, n_bytes=1714, idle_age=3764, priority=4,in_port=2,dl_vlan=5 actions=strip_vlan,NORMAL cookie=0x0, duration=4702.644s, table=0, n_packets=10650, n_bytes=447632, idle_age=0, priority=2,in_port=2 actions=drop

실제 인터페이스가 또 다른 VLAN 태그 지정된 인터페이스인 경우 실제 인터페이스는 패킷에 태그를 추가합니다.

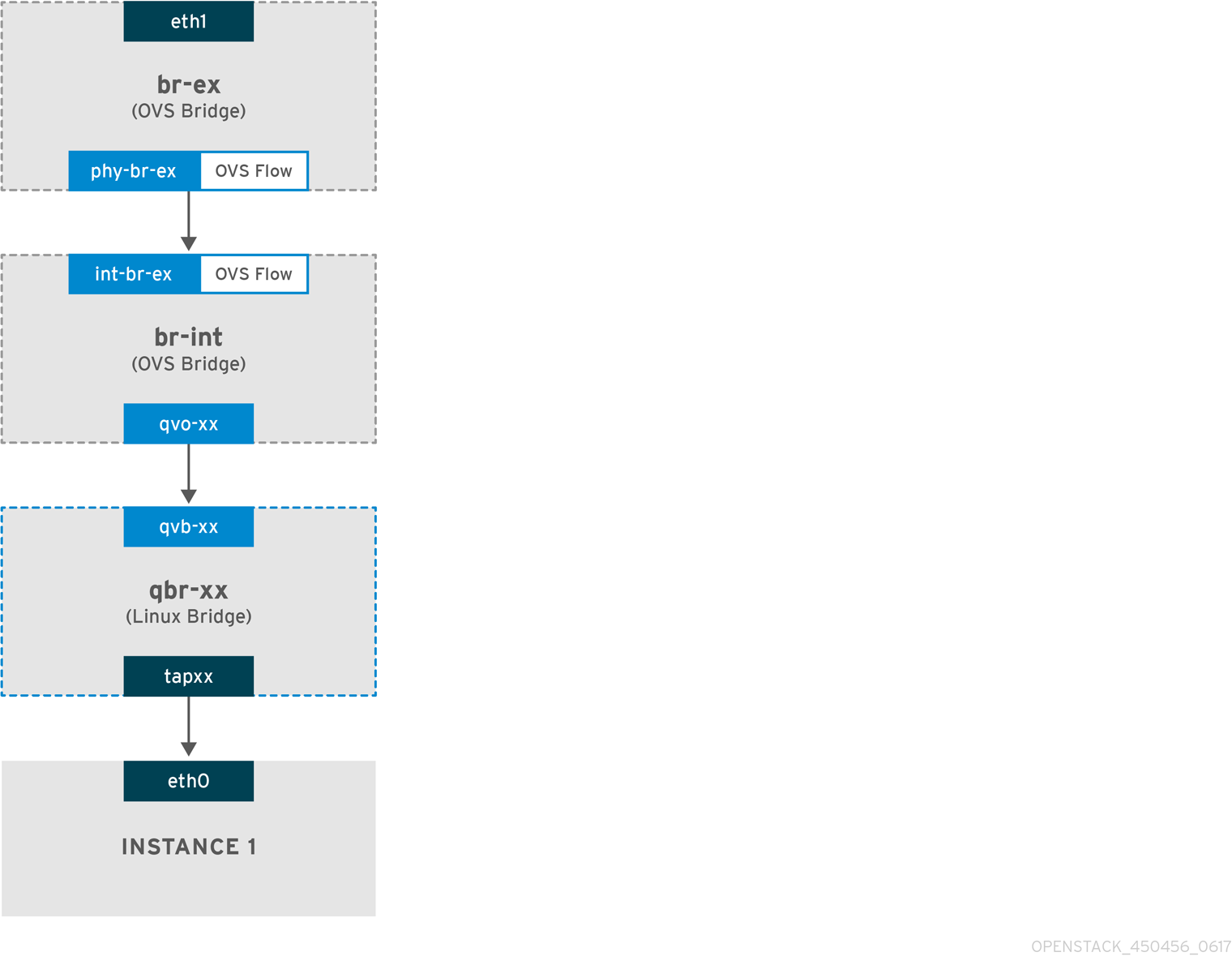

플랫 공급자 네트워크에서 들어오는 트래픽 흐름

이 섹션에는 인스턴스의 인터페이스에 도달할 때까지 외부 네트워크에서 들어오는 트래픽 흐름에 대한 정보가 포함되어 있습니다.

-

들어오는 트래픽은 물리적 노드의

eth1에 도착합니다. -

패킷이

br-ex브리지에 전달됩니다. -

패킷은 patch-peer

phy-br-ex <--> int-br-ex를 통해 br-int로 이동합니다.

다음 예에서 int-br-ex 는 포트 번호 15 를 사용합니다. 15(int-br-ex) 가 포함된 항목을 참조하십시오.

# ovs-ofctl show br-int

OFPT_FEATURES_REPLY (xid=0x2): dpid:00004e67212f644d

n_tables:254, n_buffers:256

capabilities: FLOW_STATS TABLE_STATS PORT_STATS QUEUE_STATS ARP_MATCH_IP

actions: OUTPUT SET_VLAN_VID SET_VLAN_PCP STRIP_VLAN SET_DL_SRC SET_DL_DST SET_NW_SRC SET_NW_DST SET_NW_TOS SET_TP_SRC SET_TP_DST ENQUEUE

15(int-br-ex): addr:12:4e:44:a9:50:f4

config: 0

state: 0

speed: 0 Mbps now, 0 Mbps maxbr-int에서 트래픽 흐름 관찰

패킷이

int-br-ex에도착하면br-int브리지 내의 OVS 흐름 규칙이 패킷을 수정하여 내부 VLAN 태그를 추가합니다.actions=mod_vlan_vid:5에 대한 항목을 참조하십시오.# ovs-ofctl dump-flows br-int NXST_FLOW reply (xid=0x4): cookie=0x0, duration=5351.536s, table=0, n_packets=12118, n_bytes=510456, idle_age=0, priority=1 actions=NORMAL cookie=0x0, duration=4537.553s, table=0, n_packets=3489, n_bytes=321696, idle_age=0, priority=3,in_port=15,vlan_tci=0x0000 actions=mod_vlan_vid:5,NORMAL cookie=0x0, duration=5350.365s, table=0, n_packets=628, n_bytes=57892, idle_age=4538, priority=2,in_port=15 actions=drop cookie=0x0, duration=5351.432s, table=23, n_packets=0, n_bytes=0, idle_age=5351, priority=0 actions=drop

-

두 번째 규칙은 VLAN 태그(vlan_tci=0x0000)가 없는 int-br-ex(in_port=15)에 도착하는 패킷을 관리합니다. 이 규칙은 패킷(

actions=mod_vlan_vid:5,NORMAL)에 VLAN 태그 5를 추가하고qvoxxx로 전달합니다. -

qvoXXX는 VLAN 태그를 제거한 후 패킷을 수락하고qvbxx로 전달합니다. - 그런 다음 패킷이 인스턴스에 도달합니다.

VLAN 태그 5는 플랫 프로바이더 네트워크가 있는 테스트 컴퓨팅 노드에서 사용된 VLAN의 예입니다. 이 값은 neutron-openvswitch-agent 에서 자동으로 할당했습니다. 이 값은 자체 플랫 프로바이더 네트워크에 따라 다를 수 있으며, 별도의 두 컴퓨팅 노드의 동일한 네트워크에 따라 다를 수 있습니다.

4.5. 플랫 공급자 네트워크에서 인스턴스 물리적 네트워크 연결 문제 해결

"Flat provider 네트워크 패킷 흐름은 어떻게 작동합니까?"에 제공된 출력은 모든 문제가 발생하는 경우 플랫 프로바이더 네트워크 문제 해결에 필요한 충분한 디버깅 정보를 제공합니다. 다음 단계에는 문제 해결 프로세스에 대한 추가 정보가 포함되어 있습니다.

절차

bridge_mappings를 검토합니다.사용하는 물리적 네트워크 이름이

bridge_mapping구성의 내용과 일치하는지 확인합니다.예제

이 예에서 물리적 네트워크 이름은

physnet1입니다.$ openstack network show provider-flat

샘플 출력

... | provider:physical_network | physnet1 ...

예제

이 예에서

bridge_mapping구성의 콘텐츠도physnet1입니다.$ grep bridge_mapping /etc/neutron/plugins/ml2/openvswitch_agent.ini

샘플 출력

bridge_mappings = physnet1:br-ex

네트워크 구성을 검토합니다.

네트워크가

외부로생성되고flat유형을 사용하는지 확인합니다.예제

이 예에서는

provider-flat네트워크에 대한 세부 정보를 쿼리합니다.$ openstack network show provider-flat

샘플 출력

... | provider:network_type | flat | | router:external | True | ...

patch-peer를 검토합니다.

br-int및br-ex가 patch-peerint-br-ex <--> phy-br-ex를 사용하여 연결되어 있는지 확인합니다.$ ovs-vsctl show

샘플 출력

Bridge br-int fail_mode: secure Port int-br-ex Interface int-br-ex type: patch options: {peer=phy-br-ex}샘플 출력

br-ex에서 patch-peer의 구성:Bridge br-ex Port phy-br-ex Interface phy-br-ex type: patch options: {peer=int-br-ex} Port br-ex Interface br-ex type: internal이 연결은

bridge_mapping이서비스를 다시 시작할 때 생성됩니다./etc/neutron/plugins/ml2/openvswitch-agentopenvswitch_agent.ini에 올바르게 구성된 경우 neutron-서비스를 다시 시작한 후 연결이 생성되지 않은 경우

bridge_mapping설정을 다시 확인합니다.네트워크 흐름을 검토합니다.

ovs-ofctl dump-flows br-ex및ovs-ofctl dump-flows br-ints br-ofctl dump-flows br-int를 실행하고, 흐름이 나가는 패킷의 내부 VLAN ID를 제거하고 들어오는 패킷의 VLAN ID를 추가하는지 검토합니다. 이 흐름은 먼저 특정 컴퓨팅 노드에서 이 네트워크에 인스턴스를 생성할 때 추가됩니다.-

인스턴스를 생성한 후에 이 흐름을 생성하지 않으면 네트워크가

flat, external,physical_network이름이 올바른지 확인합니다. 또한bridge_mapping설정을 검토합니다. 마지막으로

ifcfg-br-ex및ifcfg-ethx구성을 검토합니다.ethX가br-ex 내의 포트로 추가되고에ifcfg-br-ex 및ifcfg-ethxip a의 출력에UP플래그가 있는지 확인합니다.샘플 출력

다음 출력은

eth1이br-ex의 포트임을 보여줍니다.Bridge br-ex Port phy-br-ex Interface phy-br-ex type: patch options: {peer=int-br-ex} Port "eth1" Interface "eth1"예제

다음 예제에서는

eth1이 OVS 포트로 구성되어 있고 커널이 인터페이스에서 모든 패킷을 전송하고 OVS 브리지br-ex로 전송한다는 것을 보여줍니다. 이는마스터 ovs-system항목에서 확인할 수 있습니다.$ ip a 5: eth1: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc mq master ovs-system state UP qlen 1000

-

인스턴스를 생성한 후에 이 흐름을 생성하지 않으면 네트워크가

4.6. VLAN 공급자 네트워크 구성

단일 NIC의 여러 VLAN 태그 지정된 인터페이스를 여러 프로바이더 네트워크에 연결하면 이러한 새 VLAN 프로바이더 네트워크는 VM 인스턴스를 외부 네트워크에 직접 연결할 수 있습니다.

사전 요구 사항

다양한 VLAN이 있는 실제 네트워크가 있습니다.

이 예에서는 VLAN 범위가

171-172인physnet1이라는 실제 네트워크를 사용합니다.네트워크 노드 및 계산 노드는 실제 인터페이스를 사용하여 실제 네트워크에 연결됩니다.

이 예에서는 물리적 인터페이스인

eth1을 사용하여 실제 네트워크인physnet1에 연결된 네트워크 노드와 계산 노드를 사용합니다.- 이러한 인터페이스가 연결되는 스위치 포트는 필수 VLAN 범위를 트렁크하도록 구성해야 합니다.

절차

Undercloud 호스트에서 stack 사용자로 로그인한 사용자 지정 YAML 환경 파일을 만듭니다.

예제

$ vi /home/stack/templates/my-modules-environment.yaml

작은 정보Red Hat OpenStack Platform Orchestration 서비스(heat)는 templates 라는 플랜 세트를 사용하여 환경을 설치하고 구성합니다. 오케스트레이션 템플릿에 대한 사용자 지정을 제공하는 특수 유형의 템플릿 파일인 사용자 지정 환경 파일을 사용하여 오버클라우드의 특정 부분을 사용자 지정할 수 있습니다.

parameter_defaults의 YAML 환경 파일에서NeutronTypeDrivers를 사용하여 네트워크 유형 드라이버를 지정합니다.예제

parameter_defaults: NeutronTypeDrivers: vxlan,flat,vlan

사용 중인 물리적 네트워크 및 VLAN 범위를 반영하도록

NeutronNetworkVLANRanges설정을 구성합니다.예제

parameter_defaults: NeutronTypeDrivers: 'vxlan,flat,vlan' NeutronNetworkVLANRanges: 'physnet1:171:172'

외부 네트워크 브리지(br-ex)를 만들고 포트(eth1)를연결합니다.

이 예제에서는 br-ex 를 사용하도록 eth1 을 구성합니다.

예제

parameter_defaults: NeutronTypeDrivers: 'vxlan,flat,vlan' NeutronNetworkVLANRanges: 'physnet1:171:172' NeutronBridgeMappings: 'datacentre:br-ex,tenant:br-int'

openstack overcloud deploy명령을 실행하고 이 새 환경 파일을 포함하여 코어 템플릿과 환경 파일을 포함합니다.중요후속 환경 파일에 정의된 매개 변수와 리소스가 우선하기 때문에 환경 파일의 순서가 중요합니다.

예제

$ openstack overcloud deploy --templates \ -e [your-environment-files] \ -e /usr/share/openstack-tripleo-heat-templates/environments/services/my-neutron-environment.yaml

검증

외부 네트워크를

vlan유형으로 만들어 구성된physical_network와 연결합니다.다음 예제 명령을 실행하여 두 개의 네트워크를 생성합니다. 하나는 VLAN 171용이고 다른 하나는 VLAN 172에 사용됩니다.

예제

$ openstack network create \ --provider-network-type vlan \ --provider-physical-network physnet1 \ --provider-segment 171 \ provider-vlan171 $ openstack network create \ --provider-network-type vlan \ --provider-physical-network physnet1 \ --provider-segment 172 \ provider-vlan172

여러 서브넷을 만들고 외부 네트워크를 사용하도록 구성합니다.

openstack subnet create또는 대시보드를 사용하여 이러한 서브넷을 만들 수 있습니다. 네트워크 관리자가 수신한 외부 서브넷 세부 정보가 각 VLAN에 올바르게 연결되어 있는지 확인합니다.이 예에서 VLAN 171은 서브넷

10.65.217.0/24를 사용하고 VLAN 172에서는10.65.218.0/24를 사용합니다.예제

$ openstack subnet create \ --network provider-171 \ --subnet-range 10.65.217.0/24 \ --dhcp \ --gateway 10.65.217.254 \ subnet-provider-171 $ openstack subnet create \ --network provider-172 \ --subnet-range 10.65.218.0/24 \ --dhcp \ --gateway 10.65.218.254 \ subnet-provider-172

추가 리소스

- Advanced Overcloud Customization 가이드의 사용자 지정 네트워크 인터페이스 템플릿

- Advanced Overcloud Customization 가이드의 환경 파일

- Advanced Overcloud Customization 가이드에 오버클라우드 생성에 환경 파일 포함

- 명령줄 인터페이스 참조에서 네트워크 생성

- 명령줄 인터페이스 참조에서 서브넷 생성

4.7. VLAN 프로바이더 네트워크 패킷 흐름은 어떻게 작동합니까?

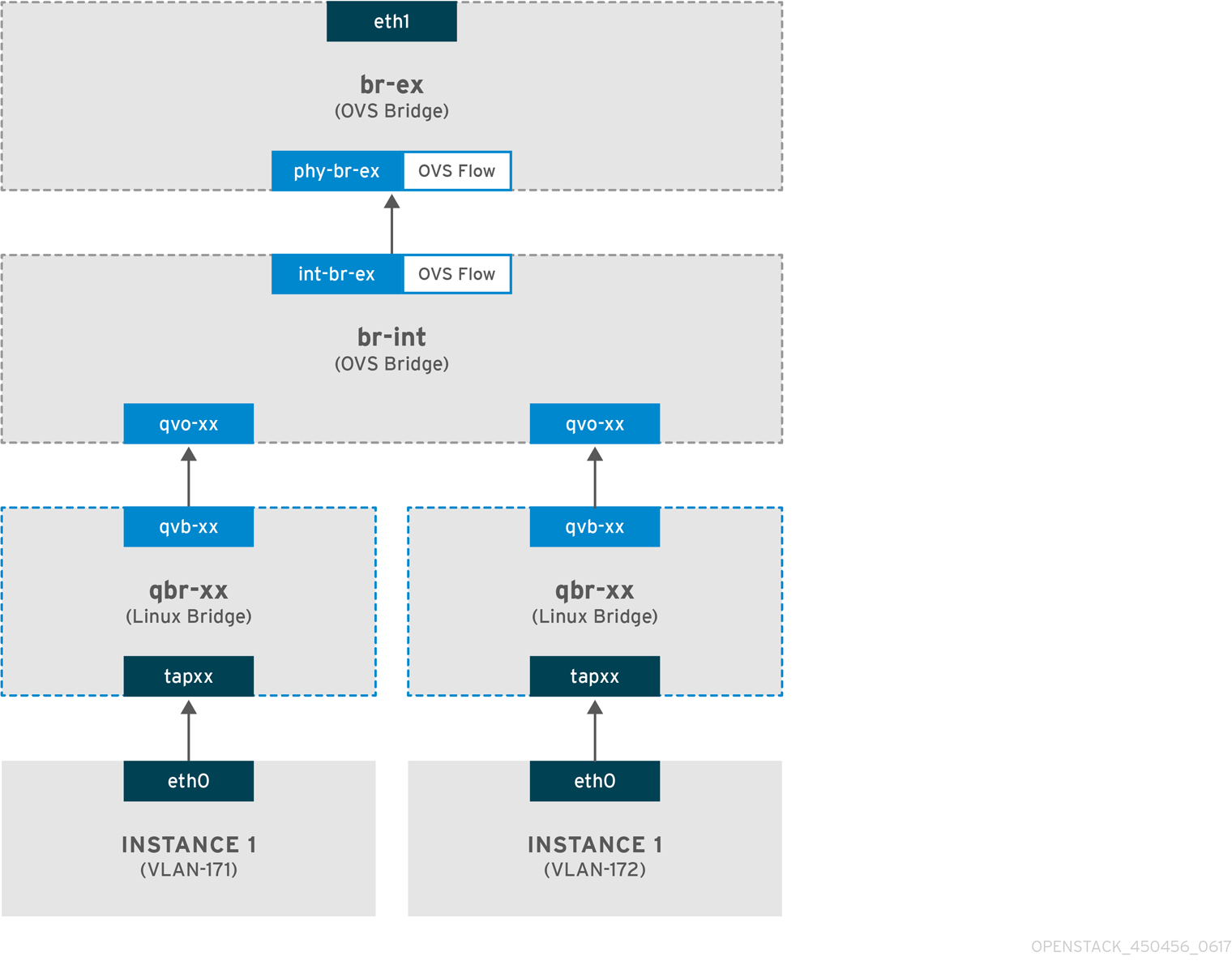

이 섹션에서는 VLAN 프로바이더 네트워크 구성이 있는 인스턴스와의 트래픽 흐름 방법을 자세히 설명합니다.

VLAN 공급자 네트워크에서 나가는 트래픽 흐름

다음 다이어그램에서는 인스턴스를 벗어나고 VLAN 프로바이더 외부 네트워크에 직접 도착하는 트래픽의 패킷 흐름을 설명합니다. 이 예에서는 두 개의 VLAN 네트워크(171 및 172)에 연결된 두 개의 인스턴스를 사용합니다. br-ex 를 구성한 후 물리적 인터페이스를 추가하고 Compute 노드에 인스턴스를 생성합니다. 결과적으로 생성된 인터페이스 및 브리지 구성은 다음 다이어그램의 구성과 유사합니다.

- 인스턴스의 eth0 인터페이스를 나가는 패킷은 인스턴스에 연결된 Linux 브리지 qbr-xx 에 도착합니다.

- qbr-xx 는 veth 쌍 qvbxx <✓ qvoxxx 를 사용하여 br-int 에 연결됩니다.

- qvbxx 는 Linux 브리지 qbr-xx 에 연결되어 있으며 qvoxx 는 Open vSwitch 브리지 br-int 에 연결됩니다.

Linux 브리지의 qbr-xx 구성 예.

이 예에서는 2개의 인스턴스와 2개의 해당 linux 브리지를 제공합니다.

# brctl show bridge name bridge id STP enabled interfaces qbr84878b78-63 8000.e6b3df9451e0 no qvb84878b78-63 tap84878b78-63 qbr86257b61-5d 8000.3a3c888eeae6 no qvb86257b61-5d tap86257b61-5d

br-int 의 qvoxx 구성 :

options: {peer=phy-br-ex}

Port "qvo86257b61-5d"

tag: 3

Interface "qvo86257b61-5d"

Port "qvo84878b78-63"

tag: 2

Interface "qvo84878b78-63"

-

qvoxx는 VLAN 프로바이더 네트워크와 연결된 내부 VLAN 태그로 태그됩니다. 이 예에서 내부 VLAN 태그 2는 VLAN 프로바이더 네트워크provider-171과 연결되며, VLAN 태그 3은 VLAN 프로바이더 네트워크provider-172와 연결됩니다. 패킷이 qvoxx 에 도달하면 이 VLAN 태그가 패킷 헤더에 추가됩니다. -

그런 다음 patch-peer

int -br-ex <❏OVS 브리지로 이동합니다. br-int의 patch- peer 예 :phy-br-ex를 사용하여 패킷이 br -ex

Bridge br-int

fail_mode: secure

Port int-br-ex

Interface int-br-ex

type: patch

options: {peer=phy-br-ex}br-ex 의 패치 피어 구성 예 :

Bridge br-ex

Port phy-br-ex

Interface phy-br-ex

type: patch

options: {peer=int-br-ex}

Port br-ex

Interface br-ex

type: internal- 이 패킷이 br -ex에서 phy-br -ex 에 도달하면 br-ex 내부의 OVS 흐름이 내부 VLAN 태그를 VLAN 프로바이더 네트워크와 연결된 실제 VLAN 태그로 교체합니다.

다음 명령의 출력은 phy-br-ex 의 포트 번호가 4 임을 보여줍니다.

# ovs-ofctl show br-ex

4(phy-br-ex): addr:32:e7:a1:6b:90:3e

config: 0

state: 0

speed: 0 Mbps now, 0 Mbps max

다음 명령은 VLAN 태그 2(dl_vlan=2)가있는 phy-br-ex(in_port=4)에 도착하는 패킷을 보여줍니다. Open vSwitch는 VLAN 태그를 171(actions=mod_vlan_vid:171,NORMAL)으로 교체하고 패킷을 실제 인터페이스로 전달합니다. 또한 명령은 VLAN 태그 3(dl_vlan=3)이있는 phy-br-ex(in_port=4)에 도착하는 모든 패킷도 표시합니다. Open vSwitch는 VLAN 태그를 172(actions=mod_vlan_vid:172,NORMAL)로 교체하고 패킷을 실제 인터페이스로 전달합니다. neutron-openvswitch-agent는 이러한 규칙을 추가합니다.

# ovs-ofctl dump-flows br-ex NXST_FLOW reply (xid=0x4): NXST_FLOW reply (xid=0x4): cookie=0x0, duration=6527.527s, table=0, n_packets=29211, n_bytes=2725576, idle_age=0, priority=1 actions=NORMAL cookie=0x0, duration=2939.172s, table=0, n_packets=117, n_bytes=8296, idle_age=58, priority=4,in_port=4,dl_vlan=3 actions=mod_vlan_vid:172,NORMAL cookie=0x0, duration=6111.389s, table=0, n_packets=145, n_bytes=9368, idle_age=98, priority=4,in_port=4,dl_vlan=2 actions=mod_vlan_vid:171,NORMAL cookie=0x0, duration=6526.675s, table=0, n_packets=82, n_bytes=6700, idle_age=2462, priority=2,in_port=4 actions=drop

- 그런 다음 이 패킷은 물리적 인터페이스 eth1 로 전달됩니다.

VLAN 공급자 네트워크에서 들어오는 트래픽 흐름

다음 예제 흐름은 프로바이더 네트워크 provider-171에 VLAN 태그 2를 사용하고 프로바이더 네트워크 provider-172의 VLAN 태그 3을 사용하여 계산 노드에서 테스트되었습니다. 흐름에서는 통합 브리지 br-int에서 18 포트를 사용합니다.

VLAN 프로바이더 네트워크에는 다른 구성이 필요할 수 있습니다. 또한 네트워크의 구성 요구 사항은 두 개의 서로 다른 컴퓨팅 노드마다 다를 수 있습니다.

다음 명령의 출력은 int-br-ex 를 포트 번호 18과 함께 표시합니다.

# ovs-ofctl show br-int

18(int-br-ex): addr:fe:b7:cb:03:c5:c1

config: 0

state: 0

speed: 0 Mbps now, 0 Mbps max다음 명령의 출력은 br-int의 흐름 규칙을 보여줍니다.

# ovs-ofctl dump-flows br-int NXST_FLOW reply (xid=0x4): cookie=0x0, duration=6770.572s, table=0, n_packets=1239, n_bytes=127795, idle_age=106, priority=1 actions=NORMAL cookie=0x0, duration=3181.679s, table=0, n_packets=2605, n_bytes=246456, idle_age=0, priority=3,in_port=18,dl_vlan=172 actions=mod_vlan_vid:3,NORMAL cookie=0x0, duration=6353.898s, table=0, n_packets=5077, n_bytes=482582, idle_age=0, priority=3,in_port=18,dl_vlan=171 actions=mod_vlan_vid:2,NORMAL cookie=0x0, duration=6769.391s, table=0, n_packets=22301, n_bytes=2013101, idle_age=0, priority=2,in_port=18 actions=drop cookie=0x0, duration=6770.463s, table=23, n_packets=0, n_bytes=0, idle_age=6770, priority=0 actions=drop

수신 흐름 예

이 예제에서는 다음 br-int OVS 흐름을 보여줍니다.

cookie=0x0, duration=3181.679s, table=0, n_packets=2605, n_bytes=246456, idle_age=0, priority=3,in_port=18,dl_vlan=172 actions=mod_vlan_vid:3,NORMAL

- 외부 네트워크의 VLAN 태그 172가 있는 패킷은 물리적 노드의 eth1 을 통해 br-ex 브리지에 도달합니다.

-

패킷은 patch-peer

phy -br-ex <-> int-br-ex를 통해 br-int 로 이동합니다. -

패킷은 흐름 기준과 일치합니다(

in_port=18,dl_vlan=172). -

흐름 작업(

actions=mod_vlan_vid:3,NORMAL)은 VLAN 태그 172를 내부 VLAN 태그 3으로 교체하고 패킷을 일반 계층 2 프로세싱으로 인스턴스에 전달합니다.

4.8. VLAN 프로바이더 네트워크에서 인스턴스 물리적 네트워크 연결 문제 해결

VLAN 프로바이더 네트워크에서 연결 문제를 해결할 때 "VLAN 프로바이더 네트워크 패킷 흐름은 어떻게 작동합니까?"에 설명된 패킷 흐름을 참조하십시오. 또한 다음 구성 옵션을 검토합니다.

절차

bridge_mapping구성에 사용된 물리적 네트워크 이름이 물리적 네트워크 이름과 일치하는지 확인합니다.예제

$ openstack network show provider-vlan171

샘플 출력

... | provider:physical_network | physnet1 ...

예제

$ grep bridge_mapping /etc/neutron/plugins/ml2/openvswitch_agent.ini

샘플 출력

이 샘플 출력에서 물리적 네트워크 이름

physnet1은bridge_mapping구성에 사용되는 이름과 일치합니다.bridge_mappings = physnet1:br-ex

네트워크가

외부로생성되었고vlan을 입력하고 올바른segmentation_id값을 사용하는지 확인합니다.예제

$ openstack network show provider-vlan171

샘플 출력

... | provider:network_type | vlan | | provider:physical_network | physnet1 | | provider:segmentation_id | 171 | ...

patch-peer를 검토합니다.

br-int및br-ex가 patch-peerint-br-ex <--> phy-br-ex를 사용하여 연결되어 있는지 확인합니다.$ ovs-vsctl show

neutron-openvswitch-agent를 다시 시작하는 동안bridge_mapping이/etc/neutron/plugins/ml2/openvswitch_agent.ini에 올바르게 구성되어 있는 경우 이 연결이 생성됩니다.서비스를 다시 시작한 후에도 이 설정이 생성되지 않은 경우

bridge_mapping설정을 다시 확인합니다.네트워크 흐름을 검토합니다.

-

발신 패킷의 흐름을 검토하려면

ovs-ofctl dump-flows br-ex및ovs-ofctl dump-flows br-ints br-ofctl dump-flows br-int를 실행하고, 흐름이 내부 VLAN ID(segmentation_id)에 매핑되는지 확인합니다. 들어오는 패킷의 경우 외부 VLAN ID를 내부 VLAN ID에 매핑합니다.

이 흐름은 이 네트워크에 인스턴스를 처음 생성할 때 neutron OVS 에이전트에서 추가합니다.

-

인스턴스를 생성한 후 이 흐름이 생성되지 않은 경우 네트워크를

vlan으로 만들고,external이고physical_network이름이 올바른지 확인합니다. 또한bridge_mapping설정을 다시 확인합니다. 마지막으로

ifcfg-br-ex및ifcfg-ethx구성을 다시 확인합니다.br-ex에ethX포트가 포함되어 있고ifcfg-br-ex및ifcfg-ethx둘 다ip a명령의 출력에UP플래그가 있는지 확인합니다.예제

$ ovs-vsctl show

이 샘플 출력에서

eth1은br-ex의 포트입니다.Bridge br-ex Port phy-br-ex Interface phy-br-ex type: patch options: {peer=int-br-ex} Port "eth1" Interface "eth1"예제

$ ip a

샘플 출력

이 샘플 출력에서

eth1이 포트로 추가되었으며 커널이 인터페이스에서 OVS 브리지br-ex로 모든 패킷을 이동하도록 구성되어 있습니다. 이는마스터 ovs-system항목에 의해 입증됩니다.5: eth1: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc mq master ovs-system state UP qlen 1000

-

발신 패킷의 흐름을 검토하려면

4.9. ML2/OVS 배포에서 공급자 네트워크의 멀티 캐스트 스누핑 활성화

RHOSP(Red Hat OpenStack Platform) 공급자 네트워크의 모든 포트에 플러딩 멀티캐스트 패킷을 방지하려면 멀티캐스트 스누핑을 활성화해야 합니다. Open vSwitch 메커니즘 드라이버(ML2/OVS)와 함께 Modular Layer 2 플러그인을 사용하는 RHOSP 배포에서는 YAML 형식의 환경 파일에 RHOSP Orchestration(heat) NeutronEnableIgmpSnooping 매개변수를 선언하여 이 작업을 수행합니다.

프로덕션 환경에 적용하기 전에 멀티캐스트 스누핑 구성을 철저하게 테스트하고 이해해야 합니다. 잘못된 구성으로 멀티캐스팅이 중단되거나 잘못된 네트워크 동작이 발생할 수 있습니다.

사전 요구 사항

- 구성은 ML2/OVS 공급자 네트워크만 사용해야 합니다.

실제 라우터에 IGMP 스누핑이 활성화되어 있어야 합니다.

즉, 물리적 라우터에서 OVS(및 물리적 네트워킹)에서 스누핑 캐시를 유지 관리하도록 멀티캐스트 그룹 구성원에서 일반 IGMP가 보고하도록 하려면 프로바이더 네트워크의 IGMP 쿼리 패킷을 보내야 합니다.

VM 인스턴스(또는 포트 보안 비활성화)에 대한 인바운드 IGMP를 허용하려면 RHOSP Networking 서비스 보안 그룹 규칙이 있어야 합니다.

이 예에서는

ping_ssh보안 그룹에 대한 규칙이 생성됩니다.예제

$ openstack security group rule create --protocol igmp --ingress ping_ssh

절차

Undercloud 호스트에서 stack 사용자로 로그인한 사용자 지정 YAML 환경 파일을 만듭니다.

예제

$ vi /home/stack/templates/my-ovs-environment.yaml

작은 정보오케스트레이션 서비스(heat)는 templates라는 플랜 집합을 사용하여 환경을 설치하고 구성합니다. heat 템플릿에 대한 사용자 지정을 제공하는 특수 유형의 템플릿 파일인 사용자 지정 환경 파일을 사용하여 오버클라우드의 특정 부분을 사용자 지정할 수 있습니다.

parameter_defaults의 YAML 환경 파일에서NeutronEnableIgmpSnooping을 true로 설정합니다.parameter_defaults: NeutronEnableIgmpSnooping: true ...중요콜론(:)과

true 사이에 공백 문자를 추가해야 합니다.openstack overcloud deploy명령을 실행하고 코어 heat 템플릿, 환경 파일 및 이 새 사용자 지정 환경 파일을 포함합니다.중요후속 환경 파일에 정의된 매개 변수와 리소스가 우선하므로 환경 파일의 순서가 중요합니다.

예제

$ openstack overcloud deploy --templates \ -e [your-environment-files] \ -e /usr/share/openstack-tripleo-heat-templates/environments/services/my-ovs-environment.yaml

검증

멀티 캐스트 스누핑이 활성화되었는지 확인합니다.

예제

# sudo ovs-vsctl list bridge br-int

샘플 출력

... mcast_snooping_enable: true ... other_config: {mac-table-size="50000", mcast-snooping-disable-flood-unregistered=True} ...

추가 리소스

- Red Hat OpenStack Platform의 구성 요소, 플러그인 및 드라이버 지원의 Neutron

- Advanced Overcloud Customization 가이드의 환경 파일

- Advanced Overcloud Customization 가이드에 오버클라우드 생성에 환경 파일 포함

- 오버클라우드 매개 변수 가이드의 네트워킹(neutron) 매개변수

- 인스턴스 생성 및 관리 가이드에서 보안 그룹 생성

4.10. ML2/OVN 배포에서 멀티 캐스트 활성화

멀티캐스트 트래픽을 지원하려면 배포의 보안 구성을 수정하여 멀티캐스트 트래픽이 멀티캐스트 그룹의 가상 시스템(VM) 인스턴스에 도달할 수 있도록 합니다. 멀티캐스트 트래픽 플러딩을 방지하기 위해 IGMP 스누핑을 활성화합니다.

프로덕션 환경에 적용하기 전에 멀티캐스트 스누핑 구성을 테스트하고 이해합니다. 잘못된 구성으로 멀티캐스팅이 중단되거나 잘못된 네트워크 동작이 발생할 수 있습니다.

사전 요구 사항

- ML2/OVN 메커니즘 드라이버를 사용한 OpenStack 배포.

절차

적절한 VM 인스턴스에 대한 멀티캐스트 트래픽을 허용하도록 보안을 구성합니다. 예를 들어 IGMP 쿼리에서 IGMP 트래픽이 VM 인스턴스를 입력하고 종료하는 데 사용할 수 있는 보안 그룹 규칙과 멀티캐스트 트래픽을 허용하는 세 번째 규칙을 만듭니다.

예제

보안 그룹 mySG 를 사용하면 IGMP 트래픽이 VM 인스턴스를 입력하고 종료할 수 있습니다.

openstack security group rule create --protocol igmp --ingress mySG openstack security group rule create --protocol igmp --egress mySG

또 다른 규칙을 사용하면 멀티캐스트 트래픽이 VM 인스턴스에 도달할 수 있습니다.

openstack security group rule create --protocol udp mySG

보안 그룹 규칙을 설정하는 대신 일부 운영자는 네트워크에서 포트 보안을 선택적으로 비활성화하도록 선택합니다. 포트 보안을 비활성화하려면 관련 보안 위험을 고려하고 계획하십시오.

heat 매개변수를 설정합니다.

NeutronEnableIgmpSnooping: True언더클라우드 노드의 환경 파일에 있습니다. 예를 들어 다음 행을 ovn-extras.yaml에 추가합니다.예제

parameter_defaults: NeutronEnableIgmpSnooping: True해당 환경과 관련된 기타 환경 파일과 함께

openstack overcloud deploy명령에 환경 파일을 포함하고 오버클라우드를 배포합니다.$ openstack overcloud deploy \ --templates \ … -e <other_overcloud_environment_files> \ -e ovn-extras.yaml \ …

<other_overcloud_environment_files>를 기존 배포에 포함된 환경 파일 목록으로 바꿉니다.

검증

멀티 캐스트 스누핑이 활성화되었는지 확인합니다. northbound 데이터베이스 Logical_Switch 테이블을 나열합니다.

$ ovn-nbctl list Logical_Switch

샘플 출력

_uuid : d6a2fbcd-aaa4-4b9e-8274-184238d66a15 other_config : {mcast_flood_unregistered="false", mcast_snoop="true"} ...Networking 서비스(neutron) igmp_snooping_enable 구성은 OVN Northbound 데이터베이스의 Logical_Switch 테이블의 other_config 열에 설정된 mcast_snoop 옵션으로 변환됩니다. mcast_flood_unregistered는 항상 "false"입니다.

IGMP 그룹을 표시합니다.

$ ovn-sbctl list IGMP_group

샘플 출력

_uuid : 2d6cae4c-bd82-4b31-9c63-2d17cbeadc4e address : "225.0.0.120" chassis : 34e25681-f73f-43ac-a3a4-7da2a710ecd3 datapath : eaf0f5cc-a2c8-4c30-8def-2bc1ec9dcabc ports : [5eaf9dd5-eae5-4749-ac60-4c1451901c56, 8a69efc5-38c5-48fb-bbab-30f2bf9b8d45] ...

추가 리소스

- Red Hat OpenStack Platform의 구성 요소, 플러그인 및 드라이버 지원의 Neutron

- Advanced Overcloud Customization 가이드의 환경 파일

- Advanced Overcloud Customization 가이드에 오버클라우드 생성에 환경 파일 포함

4.11. 컴퓨팅 메타데이터 액세스 활성화

이 장에 설명된 대로 연결된 인스턴스는 프로바이더 외부 네트워크에 직접 연결되며, 기본 게이트웨이로 외부 라우터가 구성되어 있습니다. OpenStack Networking(neutron) 라우터가 사용되지 않습니다. 즉, neutron 라우터를 사용하여 인스턴스에서 nova-metadata 서버로 메타데이터 요청을 프록시할 수 없으므로 cloud- init 를 실행하는 동안 오류가 발생할 수 있습니다. 그러나 이 문제는 메타데이터 요청을 프록시하도록 dhcp 에이전트를 구성하여 해결할 수 있습니다. /etc/neutron/dhcp_agent.ini 에서 이 기능을 활성화할 수 있습니다. 예를 들면 다음과 같습니다.

enable_isolated_metadata = True

4.12. 부동 IP 주소

유동 IP가 이미 사설 네트워크와 연결되어 있는 경우에도 동일한 네트워크를 사용하여 인스턴스에 유동 IP 주소를 할당할 수 있습니다. 이 네트워크에서 유동 IP로 할당한 주소는 네트워크 노드의 qrouter-xxx 네임스페이스에 바인딩되고 연결된 개인 IP 주소에 DNAT-SNAT 를 수행합니다. 반대로 외부 네트워크 액세스를 위해 할당한 IP 주소는 인스턴스 내부에서 직접 바인딩되며 인스턴스에서 외부 네트워크와 직접 통신할 수 있습니다.

5장. 부동 IP 주소 관리

개인, 고정 IP 주소가 있는 VM 인스턴스에는 다른 네트워크와 통신할 공용 또는 유동 IP 주소가 있을 수 있습니다. 이 섹션의 정보는 RHOSP(Red Hat OpenStack Platform) 네트워킹 서비스(neutron)를 사용하여 유동 IP를 생성하고 관리하는 방법을 설명합니다.

5.1. 유동 IP 풀 생성

유동 IP 주소를 사용하여 수신 네트워크 트래픽을 OpenStack 인스턴스로 보낼 수 있습니다. 먼저, 동적으로 인스턴스에 할당할 수 있는 유효한 라우팅 가능한 외부 IP 주소 풀을 정의해야 합니다. OpenStack Networking은 해당 유동 IP로 향하는 들어오는 모든 트래픽을 유동 IP와 연결된 인스턴스로 라우팅합니다.

OpenStack Networking에서는 CIDR 형식의 동일한 IP 범위의 모든 프로젝트(테넌트)에 유동 IP 주소를 할당합니다. 결과적으로 모든 프로젝트에서 모든 유동 IP 서브넷의 유동 IP를 사용할 수 있습니다. 특정 프로젝트의 할당량을 사용하여 이 동작을 관리할 수 있습니다. 예를 들어 Project C 및 ProjectB의 할당량을 0 으로 설정하는 동안 의 기본값을 ProjectA 및 ProjectB10 으로 설정할 수 있습니다.

절차

외부 서브넷을 만들 때 유동 IP 할당 풀을 정의할 수도 있습니다.

$ openstack subnet create --no-dhcp --allocation-pool start=IP_ADDRESS,end=IP_ADDRESS --gateway IP_ADDRESS --network SUBNET_RANGE NETWORK_NAME

서브넷 호스트에서 유동 IP 주소만 호스팅하는 경우

openstack subnet create명령에서--no-dhcp옵션을 사용하여 DHCP 할당을 비활성화하는 것이 좋습니다.예제

$ openstack subnet create --no-dhcp --allocation_pool start=192.168.100.20,end=192.168.100.100 --gateway 192.168.100.1 --network 192.168.100.0/24 public

검증

- 인스턴스에 임의의 유동 IP를 할당하여 풀이 올바르게 구성되었는지 확인할 수 있습니다. (다음의 이후 링크를 참조하십시오.)

추가 리소스

- 명령줄 인터페이스 참조에서 서브넷 생성

- 임의의 유동 IP 할당

5.2. 특정 유동 IP 할당

VM 인스턴스에 특정 유동 IP 주소를 할당할 수 있습니다.

절차

openstack server add floating ip 명령을 사용하여 인스턴스에 유동IP 주소를 할당합니다.예제

$ openstack server add floating ip prod-serv1 192.0.2.200

검증 단계

openstack server show명령을 사용하여 유동 IP가 인스턴스와 연결되어 있는지 확인합니다.예제

$ openstack server show prod-serv1

샘플 출력

+-----------------------------+------------------------------------------+ | Field | Value | +-----------------------------+------------------------------------------+ | OS-DCF:diskConfig | MANUAL | | OS-EXT-AZ:availability_zone | nova | | OS-EXT-STS:power_state | Running | | OS-EXT-STS:task_state | None | | OS-EXT-STS:vm_state | active | | OS-SRV-USG:launched_at | 2021-08-11T14:45:37.000000 | | OS-SRV-USG:terminated_at | None | | accessIPv4 | | | accessIPv6 | | | addresses | public=198.51.100.56,192.0.2.200 | | | | | config_drive | | | created | 2021-08-11T14:44:54Z | | flavor | review-ephemeral | | | (8130dd45-78f6-44dc-8173-4d6426b8e520) | | hostId | 2308c8d8f60ed5394b1525122fb5bf8ea55c78b8 | | | 0ec6157eca4488c9 | | id | aef3ca09-887d-4d20-872d-1d1b49081958 | | image | rhel8 | | | (20724bfe-93a9-4341-a5a3-78b37b3a5dfb) | | key_name | example-keypair | | name | prod-serv1 | | progress | 0 | | project_id | bd7a8c4a19424cf09a82627566b434fa | | properties | | | security_groups | name='default' | | status | ACTIVE | | updated | 2021-08-11T14:45:37Z | | user_id | 4b7e19a0d723310fd92911eb2fe59743a3a5cd32 | | | 45f76ffced91096196f646b5 | | volumes_attached | | +-----------------------------+------------------------------------------+

추가 리소스

- 명령줄 인터페이스 참조에 서버 유동 IP 추가

- 명령줄 인터페이스 참조에 서버 표시

- 임의의 유동 IP 할당

5.3. 고급 네트워크 생성

관리자 보기에서 대시 보드에 네트워크를 만들 때 관리자가 고급 네트워크 옵션을 사용할 수 있습니다. 이러한 옵션을 사용하여 프로젝트를 지정하고 사용할 네트워크 유형을 정의합니다.

절차

- 대시보드에서 Admin > Networks > Create Network > Project 를 선택합니다.

- Project(프로젝트) 드롭다운 목록에서 새 네트워크를 호스팅할 프로젝트를 선택합니다.

Provider Network Type 의 옵션을 검토합니다.

- local - 트래픽은 로컬 계산 호스트에 유지되며 외부 네트워크와 효과적으로 격리됩니다.

- 플랫 - 트래픽은 단일 네트워크에 유지되며 호스트와 공유할 수도 있습니다. VLAN 태그 지정 또는 기타 네트워크 분리가 수행되지 않습니다.

- VLAN - 실제 네트워크에 있는 VLAN에 해당하는 VLAN ID를 사용하여 네트워크를 만듭니다. 이 옵션을 사용하면 인스턴스가 동일한 계층 2 VLAN에서 시스템과 통신할 수 있습니다.

- GRE - 여러 노드에 걸쳐 있는 네트워크 오버레이를 사용하여 인스턴스 간 개별 통신을 수행합니다. 오버레이를 송신하는 트래픽의 경로가 지정되어야 합니다.

- VXLAN - GRE와 유사하며 네트워크 오버레이를 사용하여 인스턴스 간 개인 통신에 여러 노드를 확장합니다. 오버레이를 송신하는 트래픽의 경로가 지정되어야 합니다.

Create Network(네트워크 만들기)를 클릭합니다.

Project Network Topology(프로젝트 네트워크 토폴로지)를 검토하여 네트워크가 성공적으로 생성되었는지 확인합니다.

추가 리소스

5.4. 임의의 유동 IP 할당

외부 IP 주소 풀에서 VM 인스턴스에 유동 IP 주소를 동적으로 할당할 수 있습니다.

사전 요구 사항

라우팅 가능한 외부 IP 주소 풀입니다.

자세한 내용은 5.1절. “유동 IP 풀 생성”의 내용을 참조하십시오.

절차

다음 명령을 입력하여 풀에서 유동 IP 주소를 할당합니다. 이 예에서 네트워크의 이름은

public입니다.예제

$ openstack floating ip create public

샘플 출력

다음 예에서 새로 할당된 유동 IP는

192.0.2.200입니다. 인스턴스에 할당할 수 있습니다.+---------------------+--------------------------------------------------+ | Field | Value | +---------------------+--------------------------------------------------+ | fixed_ip_address | None | | floating_ip_address | 192.0.2.200 | | floating_network_id | f0dcc603-f693-4258-a940-0a31fd4b80d9 | | id | 6352284c-c5df-4792-b168-e6f6348e2620 | | port_id | None | | router_id | None | | status | ACTIVE | +---------------------+--------------------------------------------------+

다음 명령을 입력하여 인스턴스를 찾습니다.

$ openstack server list

샘플 출력

+-------------+-------------+--------+-------------+-------+-------------+ | ID | Name | Status | Networks | Image | Flavor | +-------------+-------------+--------+-------------+-------+-------------+ | aef3ca09-88 | prod-serv1 | ACTIVE | public=198. | rhel8 | review- | | 7d-4d20-872 | | | 51.100.56 | | ephemeral | | d-1d1b49081 | | | | | | | 958 | | | | | | | | | | | | | +-------------+-------------+--------+-------------+-------+-------------+

인스턴스 이름 또는 ID를 유동 IP에 연결합니다.

예제

$ openstack server add floating ip prod-serv1 192.0.2.200

검증 단계

다음 명령을 입력하여 유동 IP가 인스턴스와 연결되어 있는지 확인합니다.

예제

$ openstack server show prod-serv1

샘플 출력

+-----------------------------+------------------------------------------+ | Field | Value | +-----------------------------+------------------------------------------+ | OS-DCF:diskConfig | MANUAL | | OS-EXT-AZ:availability_zone | nova | | OS-EXT-STS:power_state | Running | | OS-EXT-STS:task_state | None | | OS-EXT-STS:vm_state | active | | OS-SRV-USG:launched_at | 2021-08-11T14:45:37.000000 | | OS-SRV-USG:terminated_at | None | | accessIPv4 | | | accessIPv6 | | | addresses | public=198.51.100.56,192.0.2.200 | | | | | config_drive | | | created | 2021-08-11T14:44:54Z | | flavor | review-ephemeral | | | (8130dd45-78f6-44dc-8173-4d6426b8e520) | | hostId | 2308c8d8f60ed5394b1525122fb5bf8ea55c78b8 | | | 0ec6157eca4488c9 | | id | aef3ca09-887d-4d20-872d-1d1b49081958 | | image | rhel8 | | | (20724bfe-93a9-4341-a5a3-78b37b3a5dfb) | | key_name | example-keypair | | name | prod-serv1 | | progress | 0 | | project_id | bd7a8c4a19424cf09a82627566b434fa | | properties | | | security_groups | name='default' | | status | ACTIVE | | updated | 2021-08-11T14:45:37Z | | user_id | 4b7e19a0d723310fd92911eb2fe59743a3a5cd32 | | | 45f76ffced91096196f646b5 | | volumes_attached | | +-----------------------------+------------------------------------------+

추가 리소스

- 명령줄 인터페이스 참조에서 부동 IP 만들기

- 명령줄 인터페이스 참조에 서버 유동 IP 추가

- 명령줄 인터페이스 참조에 서버 표시

- 부동 IP 풀 생성

5.5. 여러 유동 IP 풀 생성

OpenStack Networking에서는 각 L3 에이전트에 대해 하나의 유동 IP 풀을 지원합니다. 따라서 추가 유동 IP 풀을 생성하려면 L3 에이전트를 확장해야 합니다.

절차

-

사용자 환경의 L3 에이전트에 대해

/var/lib/config-data/neutron/neutron.conf속성handle_internal_only_routers가True로 설정되어 있는지 확인합니다. 이 옵션은 외부가 아닌 라우터만 관리하도록 L3 에이전트를 구성합니다.

추가 리소스

5.6. 물리적 네트워크 브리징

가상 네트워크를 실제 네트워크로 연결하여 가상 인스턴스와 연결할 수 있도록 합니다.

이 절차에서 실제 인터페이스의 예로 eth0 이 브리지 br-ex 에 매핑됩니다. 가상 브리지는 실제 네트워크와 모든 가상 네트워크 간의 중간 역할을 합니다.

결과적으로 eth0 을 통과하는 모든 트래픽은 구성된 Open vSwitch를 사용하여 인스턴스에 연결합니다.

물리적 NIC를 가상 Open vSwitch 브리지에 매핑하려면 다음 단계를 완료합니다.

절차

텍스트 편집기에서

/etc/sysconfig/network-scripts/ifcfg-eth0을 열고 사이트의 네트워크에 적합한 값으로 다음 매개변수를 업데이트합니다.- IPADDR

- 넷마스크 게이트웨이

DNS1 (이름 서버)

예를 들면 다음과 같습니다.

# vi /etc/sysconfig/network-scripts/ifcfg-eth0 DEVICE=eth0 TYPE=OVSPort DEVICETYPE=ovs OVS_BRIDGE=br-ex ONBOOT=yes

텍스트 편집기에서

/etc/sysconfig/network-scripts/ifcfg-br-ex를 열고 이전에 eth0에 할당된 IP 주소 값으로 가상 브리지 매개변수를 업데이트합니다.# vi /etc/sysconfig/network-scripts/ifcfg-br-ex DEVICE=br-ex DEVICETYPE=ovs TYPE=OVSBridge BOOTPROTO=static IPADDR=192.168.120.10 NETMASK=255.255.255.0 GATEWAY=192.168.120.1 DNS1=192.168.120.1 ONBOOT=yes

이제 인스턴스에 유동 IP 주소를 할당하고 실제 네트워크에서 사용할 수 있도록 설정할 수 있습니다.

추가 리소스

5.7. 인터페이스 추가

라우터가 중간 서브넷 외부의 대상으로 보내는 트래픽을 보낼 수 있도록 인터페이스를 사용하여 서브넷과 라우터를 상호 연결할 수 있습니다.

라우터 인터페이스를 추가하고 새 인터페이스를 서브넷에 연결하려면 다음 단계를 완료합니다.

이 절차에서는 네트워크 토폴로지 기능을 사용합니다. 이 기능을 사용하면 네트워크 관리 작업을 수행하는 동안 모든 가상 라우터 및 네트워크를 그래픽으로 표시할 수 있습니다.

- 대시보드에서 프로젝트 > 네트워크 > 네트워크 토폴로지 를 선택합니다.

- 관리할 라우터를 찾아 마우스 커서를 올려 놓은 다음 Add Interface(인터페이스 추가 )를 클릭합니다.

라우터에 연결할 서브넷을 지정합니다.

IP 주소도 지정할 수 있습니다. 이 인터페이스에 대한 ping은 트래픽이 예상대로 라우팅되고 있음을 나타내므로 주소가 테스트 및 문제 해결에 유용합니다.

Add interface (인터페이스 추가)를 클릭합니다.

네트워크 토폴로지 다이어그램은 라우터와 서브넷 간의 새 인터페이스 연결을 반영하도록 자동으로 업데이트됩니다.

5.8. 인터페이스 삭제

서브넷의 트래픽을 전달하는 데 라우터가 더 이상 필요하지 않은 경우 서브넷으로 인터페이스를 제거할 수 있습니다.

인터페이스를 삭제하려면 다음 단계를 완료합니다.

- 대시보드에서 프로젝트 > 네트워크 > 라우터 를 선택합니다.

- 삭제할 인터페이스를 호스팅하는 라우터 이름을 클릭합니다.

- 인터페이스 유형(내부 인터페이스)을 선택하고 Delete Interfaces(인터페이스 삭제 )를 클릭합니다.

6장. 네트워크 문제 해결

Red Hat OpenStack Platform에서 네트워크 연결 문제 해결 진단 프로세스는 물리적 네트워크의 진단 프로세스와 유사합니다. VLAN을 사용하는 경우 가상 인프라를 완전히 분리된 환경이 아니라 실제 네트워크의 트렁크 확장으로 간주할 수 있습니다. ML2/OVS 네트워크와 기본 ML2/OVN 네트워크 문제 해결에는 몇 가지 차이점이 있습니다.

6.1. 기본 ping 테스트

ping 명령은 네트워크 연결 문제를 분석하는 데 유용한 도구입니다. 결과는 네트워크 연결의 기본 지표 역할을 하지만 실제 애플리케이션 트래픽을 차단하는 방화벽과 같은 모든 연결 문제를 완전히 제외하지는 않을 수 있습니다. ping 명령은 트래픽을 특정 대상으로 전송한 다음 시도가 성공했는지 여부를 다시 보고합니다.

ping 명령은 ICMP 작업입니다. ping 을 사용하려면 ICMP 트래픽이 중간 방화벽을 통과하는 것을 허용해야 합니다.

ping 테스트는 네트워크 문제가 발생한 시스템에서 실행할 때 가장 유용하므로 시스템이 완전히 오프라인인 것처럼 보이면 VNC 관리 콘솔을 통해 명령줄에 연결해야 할 수도 있습니다.

예를 들어 다음 ping test 명령은 성공하기 위해 여러 계층의 네트워크 인프라의 유효성을 검사합니다. 이름 확인, IP 라우팅 및 네트워크 스위칭이 모두 올바르게 작동해야 합니다.

$ ping www.example.com PING e1890.b.akamaiedge.net (125.56.247.214) 56(84) bytes of data. 64 bytes from a125-56.247-214.deploy.akamaitechnologies.com (125.56.247.214): icmp_seq=1 ttl=54 time=13.4 ms 64 bytes from a125-56.247-214.deploy.akamaitechnologies.com (125.56.247.214): icmp_seq=2 ttl=54 time=13.5 ms 64 bytes from a125-56.247-214.deploy.akamaitechnologies.com (125.56.247.214): icmp_seq=3 ttl=54 time=13.4 ms ^C

결과 요약이 표시되는 Ctrl-c를 사용하여 ping 명령을 종료할 수 있습니다. 제로 비율의 패킷 손실은 연결이 안정적이며 시간 초과되지 않았음을 나타냅니다.

--- e1890.b.akamaiedge.net ping statistics --- 3 packets transmitted, 3 received, 0% packet loss, time 2003ms rtt min/avg/max/mdev = 13.461/13.498/13.541/0.100 ms

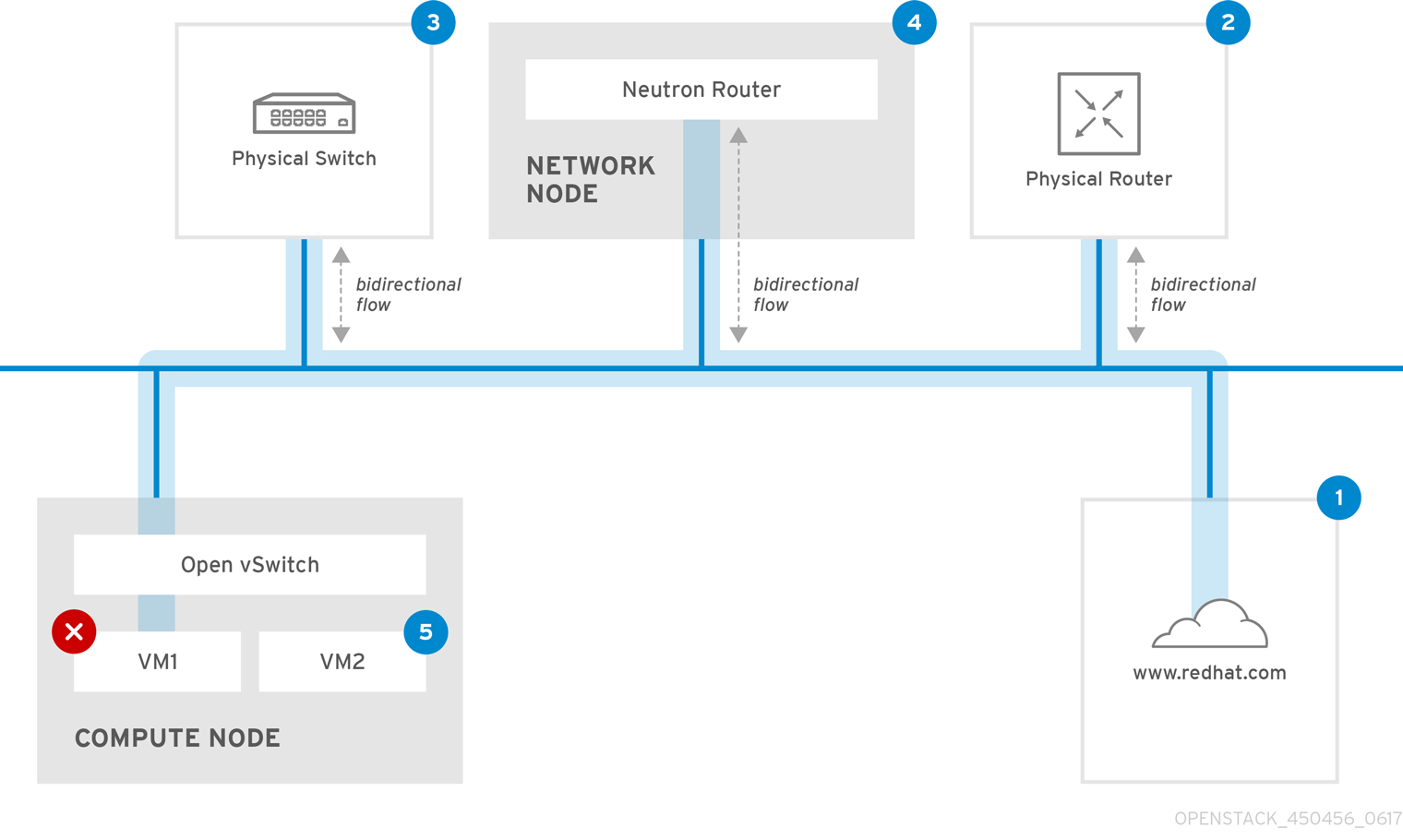

테스트 대상에 따라 ping 테스트 결과가 매우 표시될 수 있습니다. 예를 들어 다음 다이어그램 VM1에서는 몇 가지 형태의 연결 문제가 발생했습니다. 가능한 대상에는 파란색으로 번호가 지정되며 성공 또는 실패한 결과에서 얻은 결론이 표시됩니다.

인터넷 - 일반적인 첫 번째 단계는 www.example.com과 같은 인터넷 위치에 ping 테스트를 보내는 것입니다.