Red Hat Training

A Red Hat training course is available for Red Hat OpenStack Platform

고급 오버클라우드 사용자 지정

Red Hat OpenStack Platform director를 사용하여 고급 기능 구성 방법

OpenStack Documentation Team

rhos-docs@redhat.com초록

1장. 소개

Red Hat OpenStack Platform director는 Overcloud라는 완전한 기능을 갖춘 OpenStack 환경을 프로비저닝하고 생성하는 툴 세트를 제공합니다. Director 설치 및 사용 가이드에서 는 Overcloud 준비 및 설정에 대해 다룹니다. 그러나 프로덕션 수준의 Overcloud에는 다음과 같은 추가 구성이 필요할 수 있습니다.

- Overcloud를 기존 네트워크 인프라에 통합하기 위한 기본 네트워크 구성입니다.

- 특정 OpenStack 네트워크 트래픽 유형에 대한 별도의 VLAN에서 네트워크 트래픽 분리

- 공용 끝점에서 통신을 보호하는 SSL 구성

- NFS, iSCSI, Red Hat Ceph Storage 및 여러 타사 스토리지 장치와 같은 스토리지 옵션입니다.

- Red Hat Content Delivery Network 또는 내부 Red Hat Satellite 5 또는 6 서버에 노드를 등록합니다.

- 다양한 시스템 수준 옵션

- 다양한 OpenStack 서비스 옵션.

이 안내서에서는 director를 통해 Overcloud를 보강하는 방법을 설명합니다. 이 시점에서 director는 노드를 등록하고 Overcloud 생성에 필요한 서비스를 구성했습니다. 이제 이 가이드의 방법을 사용하여 Overcloud를 사용자 지정할 수 있습니다.

이 가이드의 예는 Overcloud 구성을 위한 선택적 단계입니다. 다음 단계는 오버클라우드에 추가 기능만 제공해야 합니다. 환경 요구에 적용되는 단계만 사용합니다.

2장. Heat 템플릿 이해

이 가이드의 사용자 지정 구성에서는 Heat 템플릿 및 환경 파일을 사용하여 Overcloud의 특정 측면을 정의합니다. 이 장에서는 Heat 템플릿에 대한 기본 소개를 제공하므로 Red Hat OpenStack Platform director의 컨텍스트에서 이러한 템플릿의 구조와 형식을 이해할 수 있습니다.

2.1. Heat 템플릿

director는 HOT(Heat Orchestration Templates)를 Overcloud 배포 계획의 템플릿 형식으로 사용합니다. DestinationRule 형식의 템플릿은 대부분 YAML 형식으로 표시됩니다. 템플릿의 목적은 heat가 생성하는 리소스 컬렉션 및 리소스 구성인 스택 을 정의하고 생성하는 것입니다. 리소스는 OpenStack의 오브젝트이며 컴퓨팅 리소스, 네트워크 구성, 보안 그룹, 스케일링 규칙 및 사용자 정의 리소스를 포함할 수 있습니다.

Heat 템플릿의 구조에는 세 가지 주요 섹션이 있습니다.

- 매개 변수

-

이러한 설정은 heat에 전달됩니다. 이 설정은 스택을 사용자 지정하는 방법과 전달된 값 없이 매개변수의 기본값을 제공하는 설정입니다. 이러한 값은 템플릿의

parameters섹션에 정의되어 있습니다. - Resources

-

이러한 오브젝트는 스택의 일부로 생성하고 구성할 특정 오브젝트입니다. OpenStack에는 모든 구성 요소에 걸쳐 있는 핵심 리소스 세트가 포함되어 있습니다. 이러한 값은 템플릿의

resources섹션에 정의되어 있습니다. - 출력 결과

-

이는 스택 생성 후 heat에서 전달된 값입니다. heat API 또는 클라이언트 도구를 통해 이러한 값에 액세스할 수 있습니다. 이러한 값은 템플릿의

output섹션에 정의되어 있습니다.

다음은 기본 heat 템플릿의 예입니다.

heat_template_version: 2013-05-23

description: > A very basic Heat template.

parameters:

key_name:

type: string

default: lars

description: Name of an existing key pair to use for the instance

flavor:

type: string

description: Instance type for the instance to be created

default: m1.small

image:

type: string

default: cirros

description: ID or name of the image to use for the instance

resources:

my_instance:

type: OS::Nova::Server

properties:

name: My Cirros Instance

image: { get_param: image }

flavor: { get_param: flavor }

key_name: { get_param: key_name }

output:

instance_name:

description: Get the instance's name

value: { get_attr: [ my_instance, name ] }

이 템플릿은 리소스 유형인 OS::Nova::Server 를 사용하여 특정 플레이버, 이미지 및 키가 있는 my_instance 라는 인스턴스를 생성합니다. 스택은 My Cirros Instance 라고 하는 instance_name 의 값을 반환할 수 있습니다.

Heat에서 템플릿을 처리할 때 템플릿의 스택과 리소스 템플릿의 하위 스택 세트를 생성합니다. 이렇게 하면 템플릿으로 정의한 기본 스택에서 종료되는 스택 계층이 생성됩니다. 다음 명령을 사용하여 스택 계층을 볼 수 있습니다.

$ openstack stack list --nested

2.2. 환경 파일

환경 파일은 Heat 템플릿에 대한 사용자 지정을 제공하는 특수한 유형의 템플릿입니다. 여기에는 세 가지 주요 부분이 포함됩니다.

- 리소스 레지스트리

-

이 섹션에서는 다른 heat 템플릿에 연결된 사용자 정의 리소스 이름을 정의합니다. 이는 기본적으로 core 리소스 컬렉션에 없는 사용자 정의 리소스를 생성하는 방법을 제공합니다. 이러한 값은 환경 파일의

resource_registry섹션에 정의되어 있습니다. - 매개 변수

-

이러한 설정은 최상위 템플릿의 매개변수에 적용되는 일반적인 설정입니다. 예를 들어 리소스 레지스트리 매핑과 같이 중첩된 스택을 배포하는 템플릿이 있는 경우 매개변수는 최상위 템플릿에만 적용되며 중첩 리소스에 대한 템플릿은 아닙니다. 매개변수는 환경 파일의

parameters섹션에 정의됩니다. - 매개변수 기본값

-

이러한 매개변수는 모든 템플릿에서 매개변수의 기본값을 수정합니다. 예를 들어 리소스 레지스트리 매핑과 같이 중첩 스택을 배포하는 Heat 템플릿이 있는 경우 매개변수 기본값은 모든 템플릿에 적용됩니다. 즉 최상위 템플릿과 모든 중첩 리소스를 정의하는 템플릿입니다. 매개변수 기본값은 환경 파일의

parameter_defaults섹션에 정의됩니다.

Overcloud에 대한 사용자 지정 환경 파일을 생성할 때 매개변수 대신 parameter_defaults 를 사용하는 것이 좋습니다. 이렇게 하면 매개변수가 Overcloud의 모든 스택 템플릿에 적용됩니다.

기본 환경 파일의 예는 다음과 같습니다.

resource_registry: OS::Nova::Server::MyServer: myserver.yaml parameter_defaults: NetworkName: my_network parameters: MyIP: 192.168.0.1

예를 들어 특정 Heat 템플릿(my_template.yaml)에서 스택을 생성할 때 이 환경 파일(my_env.yaml)이 포함될 수 있습니다. my_env.yaml 파일은 OS::Nova::Server::MyServer 라는 새 리소스 유형을 생성합니다. myserver.yaml 파일은 기본 제공 파일을 덮어쓰는 이 리소스 유형에 대한 구현을 제공하는 Heat 템플릿 파일입니다. OS::Nova::Server::MyServer 리소스를 my_template.yaml 파일에 포함할 수 있습니다.

MyIP 는 이 환경 파일과 함께 배포하는 기본 Heat 템플릿에만 매개변수를 적용합니다. 이 예제에서는 my_template.yaml 의 매개변수에만 적용됩니다.

NetworkName 은 기본 Heat 템플릿(이 예제에서는 my_template.yaml)과 기본 템플릿이 포함된 리소스와 관련된 템플릿(예: OS::Nova::Server::MyServer 리소스 및 myserver.yaml 템플릿)에 모두 적용됩니다.

2.3. 코어 Overcloud Heat 템플릿

director에는 Overcloud의 핵심 heat 템플릿 컬렉션이 포함되어 있습니다. 이 컬렉션은 /usr/share/openstack-tripleo-heat-templates 에 저장됩니다.

이 컬렉션에는 많은 heat 템플릿과 환경 파일이 있습니다. 그러나 이 템플릿 컬렉션에서 유의해야 할 주요 파일과 디렉터리는 다음과 같습니다.

overcloud.j2.yaml- 이는 Overcloud 환경을 생성하는 데 사용되는 기본 템플릿 파일입니다. 이 파일은 Jinja2 구문을 사용하여 템플릿의 특정 섹션을 반복하여 사용자 지정 역할을 만듭니다. Jinja2 형식은 오버클라우드 배포 프로세스 중에 YAML로 렌더링됩니다.

overcloud-resource-registry-puppet.j2.yaml- 이는 Overcloud 환경을 생성하는 데 사용되는 기본 환경 파일입니다. Overcloud 이미지에 저장된 Puppet 모듈 구성을 제공합니다. director가 각 노드에 Overcloud 이미지를 쓰면 Heat에서 이 환경 파일에 등록된 리소스를 사용하여 각 노드의 Puppet 구성을 시작합니다. 이 파일은 Jinja2 구문을 사용하여 템플릿의 특정 섹션을 반복하여 사용자 지정 역할을 만듭니다. Jinja2 형식은 오버클라우드 배포 프로세스 중에 YAML로 렌더링됩니다.

roles_data.yaml- 오버클라우드에서 역할을 정의하고 서비스를 각 역할에 매핑하는 파일입니다.

capabilities-map.yaml-

오버클라우드 계획에 대한 환경 파일 매핑입니다. 이 파일을 사용하여 director의 웹 UI를 통해 환경 파일을 설명하고 활성화합니다. 오버클라우드 계획에서 감지되었지만

capabilities-map.yaml에 나열되지 않은 사용자 지정 환경 파일은 웹 UI의 지정 배포 구성 > 전체 설정 의 기타 그룹에 나열됩니다. 환경-

오버클라우드 생성 시 사용할 수 있는 추가 Heat 환경 파일이 포함되어 있습니다. 이러한 환경 파일을 사용하면 생성된 OpenStack 환경에 추가 기능을 사용할 수 있습니다. 예를 들어 디렉터리에는 Cinder NetApp 백엔드 스토리지(

cinder-netapp-config.yaml)를 활성화하기 위한 환경 파일이 포함되어 있습니다. network- 격리된 네트워크 및 포트를 만드는 데 도움이 되는 Heat 템플릿 집합입니다.

Puppet-

주로 puppet을 사용하여 구성으로 구동되는 템플릿입니다. 앞서 언급한

overcloud-resource-registry-puppet.j2.yaml환경 파일은 이 디렉터리의 파일을 사용하여 각 노드에서 Puppet 구성의 애플리케이션을 구동합니다. Puppet/서비스- 구성 가능 서비스 아키텍처의 모든 서비스에 대한 heat 템플릿이 포함된 디렉터리입니다.

extraconfig-

추가 기능을 활성화하는 데 사용되는 템플릿입니다. 예를 들어

extraconfig/pre_deploy/rhel-registrationdirector는 노드의 Red Hat Enterprise Linux 운영 체제를 Red Hat Content Delivery 네트워크 또는 자체 Red Hat Satellite 서버에 등록할 수 있는 기능을 제공합니다. firstboot-

처음 노드를 생성할 때 director에서 사용하는

first_boot스크립트 예제를 제공합니다.

2.4. 오버클라우드 생성에 환경 파일 포함

배포 명령(openstack overcloud deploy)은 -e 옵션을 사용하여 환경 파일을 포함하여 Overcloud를 사용자 지정합니다. 환경 파일은 필요한 수만큼 추가할 수 있습니다. 차후에 실행되는 환경 파일에 정의된 매개변수와 리소스가 우선순위를 갖기 때문에 환경 파일의 순서가 중요합니다. 예를 들어 두 개의 환경 파일이 있을 수 있습니다.

environment-file-1.yaml

resource_registry: OS::TripleO::NodeExtraConfigPost: /home/stack/templates/template-1.yaml parameter_defaults: RabbitFDLimit: 65536 TimeZone: 'Japan'

environment-file-2.yaml

resource_registry: OS::TripleO::NodeExtraConfigPost: /home/stack/templates/template-2.yaml parameter_defaults: TimeZone: 'Hongkong'

그런 다음 포함된 두 환경 파일을 모두 사용하여 배포합니다.

$ openstack overcloud deploy --templates -e environment-file-1.yaml -e environment-file-2.yaml

이 예제에서는 두 환경 파일에 공통 리소스 유형(OS::TripleO::NodeExtraConfigPost)과 공통 매개변수(TimeZone)가 포함되어 있습니다. openstack overcloud deploy 명령은 다음 프로세스를 통해 실행됩니다.

-

--template옵션에 따라 코어 Heat 템플릿 컬렉션에서 기본 구성을 로드합니다. -

기본 구성의 공통 설정을 재정의하는

environment-file-1.yaml의 구성을 적용합니다. -

기본 구성 및

environment-file-1.yaml의 공통 설정을 재정의하는environment-file-2.yaml의 구성을 적용합니다.

그러면 Overcloud의 기본 구성이 다음과 같이 변경됩니다.

-

OS::TripleO::NodeExtraConfigPost리소스는environment-file-2.yaml에 따라/home/stack/templates/template-2.yaml로 설정됩니다. -

timezone매개변수는environment-file-2.yaml에 따라Hongkong으로 설정됩니다. -

RabbitFDLimit매개변수는environment-file-1.yaml에 따라65536으로 설정됩니다.environment-file-2.yaml은 이 값을 변경하지 않습니다.

이를 통해 여러 환경 파일의 값 없이 Overcloud에 대한 사용자 지정 구성을 정의할 수 있습니다.

2.5. 사용자 지정된 코어 Heat 템플릿 사용

오버클라우드를 생성할 때 director는 /usr/share/openstack-tripleo-heat-templates 에 있는 코어 Heat 템플릿 세트를 사용합니다. 이 핵심 템플릿 컬렉션을 사용자 정의하려면 Git 워크플로를 사용하여 변경 사항을 추적하고 업데이트를 병합합니다. 다음 git 프로세스를 사용하여 사용자 정의 템플릿 컬렉션을 관리할 수 있습니다.

사용자 정의 템플릿 컬렉션 초기화

다음 절차에 따라 Heat 템플릿 컬렉션이 포함된 초기 Git 리포지토리를 생성합니다.

템플릿의 디렉터리를

stackusers 디렉터리에 복사합니다. 이 예에서는~/templates디렉터리에 복사합니다.$ cd ~/templates $ cp -r /usr/share/openstack-tripleo-heat-templates .

사용자 정의 템플릿 디렉터리로 변경하고 Git 리포지토리를 초기화합니다.

$ cd openstack-tripleo-heat-templates $ git init .

초기 커밋을 위한 모든 템플릿을 준비합니다.

$ git add *

초기 커밋을 생성합니다.

$ git commit -m "Initial creation of custom core heat templates"

이렇게 하면 최신 코어 템플릿 컬렉션이 포함된 초기 마스터 분기가 생성됩니다. 이 분기를 사용자 정의 분기의 기준으로 사용하고 새 템플릿 버전을 이 분기에 병합합니다.

사용자 정의 분기 및 변경 사항 생성

변경 사항을 코어 템플릿 컬렉션에 저장하려면 사용자 정의 분기를 사용합니다. 다음 절차에 따라 my-customizations 분기를 생성하고 사용자 지정을 추가합니다.

my-customizations분기를 생성하여 다음으로 전환합니다.$ git checkout -b my-customizations

- 사용자 지정 분기의 파일을 편집합니다.

git에서 변경 사항을 스테이징합니다.

$ git add [edited files]

사용자 정의 분기에 변경 사항을 커밋합니다.

$ git commit -m "[Commit message for custom changes]"

이렇게 하면 커밋으로 변경 사항이 my-customizations 분기에 추가됩니다. 마스터 분기가 업데이트되면 마스터 사용자 지정을 다시 기반으로 하여 git이 업데이트된 템플릿 컬렉션에 이러한 커밋을 추가할 수 있습니다. 이를 통해 사용자 정의를 추적하고 향후 템플릿 업데이트에서 재생하는 데 도움이 됩니다.

사용자 정의 템플릿 컬렉션 업데이트:

언더클라우드를 업데이트할 때 openstack-tripleo-heat-templates 패키지도 업데이트할 수 있습니다. 사용자 정의 템플릿 컬렉션을 업데이트하려면 다음 절차를 사용하십시오.

openstack-tripleo-heat-templates패키지 버전을 환경 변수로 저장합니다.$ export PACKAGE=$(rpm -qv openstack-tripleo-heat-templates)

템플릿 컬렉션 디렉터리로 변경하고 업데이트된 템플릿에 대한 새 분기를 생성합니다.

$ cd ~/templates/openstack-tripleo-heat-templates $ git checkout -b $PACKAGE

분기의 모든 파일을 제거하고 새 버전으로 교체합니다.

$ git rm -rf * $ cp -r /usr/share/openstack-tripleo-heat-templates/* .

초기 커밋에 대한 모든 템플릿을 추가합니다.

$ git add *

패키지 업데이트에 대한 커밋을 생성합니다.

$ git commit -m "Updates for $PACKAGE"

분기를 master에 병합합니다. GitLab과 같은 Git 관리 시스템을 사용하는 경우 관리 워크플로를 사용합니다. git을 로컬로 사용하는 경우

master분기로 전환하고git merge명령을 실행하여 병합합니다.$ git checkout master $ git merge $PACKAGE

이제 master 분기에 코어 템플릿 컬렉션의 최신 버전이 포함됩니다. 이제 이 업데이트된 컬렉션에서 my-customization 분기를 리베이스할 수 있습니다.

사용자 정의 분기 리베이스

my-customization 분기를 업데이트하려면 다음 절차를 사용합니다.

my-customizations분기로 변경합니다.$ git checkout my-customizations

master에서 분기를 리베이스 :$ git rebase master

이렇게 하면 my-customizations 분기가 업데이트되고 이 분기에 수행된 사용자 지정 커밋이 재생됩니다.

리베이스 중 git에서 충돌을 보고하는 경우 다음 절차를 사용하십시오.

충돌이 포함된 파일을 확인합니다.

$ git status

- 확인된 템플릿 파일의 충돌을 해결합니다.

해결된 파일 추가

$ git add [resolved files] $ git commit

리베이스를 계속합니다.

$ git rebase --continue

사용자 정의 템플릿 배포

사용자 지정 템플릿 컬렉션을 배포하려면 다음 절차를 사용하십시오.

my-customization분기로 전환했는지 확인합니다.git checkout my-customizations

--templates옵션과 함께openstack overcloud deploy명령을 실행하여 로컬 템플릿 디렉터리를 지정합니다.$ openstack overcloud deploy --templates /home/stack/templates/openstack-tripleo-heat-templates [OTHER OPTIONS]

director는 디렉터리 없이 --templates 옵션을 지정하는 경우 기본 템플릿 디렉터리(/usr/share/openstack-tripleo-heat-templates)를 사용합니다.

Red Hat은 heat 템플릿 컬렉션을 수정하는 대신 다음 섹션의 방법을 사용하는 것이 좋습니다.

3장. 매개 변수

director의 템플릿 컬렉션의 각 Heat 템플릿에는 parameters 섹션이 포함되어 있습니다. 이 섹션에서는 특정 오버클라우드 서비스와 관련된 모든 매개변수를 정의합니다. 여기에는 다음이 포함됩니다.

-

overcloud.j2.yaml- 기본 기본 매개변수 -

roles_data.yaml- 구성 가능 역할의 기본 매개변수 -

Puppet/services/*.yaml- 특정 서비스의 기본 매개변수

다음 방법을 사용하여 이러한 매개변수의 값을 수정할 수 있습니다.

- 사용자 정의 매개변수에 대한 환경 파일을 생성합니다.

-

사용자 정의 매개변수를 환경 파일의

parameter_defaults섹션에 포함합니다. -

openstack overcloud deploy명령을 사용하여 환경 파일을 포함합니다.

다음 부분에서는 puppet/services 디렉터리에서 서비스에 대한 특정 매개변수를 구성하는 방법을 보여주는 예제가 포함되어 있습니다.

3.1. 예: 시간대 구성

시간대(puppet/services/time/timezone.yaml)를 설정하는 Heat 템플릿에는 TimeZone 매개변수가 포함되어 있습니다. TimeZone 매개변수를 비워 두면 오버클라우드는 시간을 기본값으로 UTC 로 설정합니다. director는 시간대 데이터베이스 /usr/share/zoneinfo/ 에 정의된 표준 시간대 이름을 인식합니다. 예를 들어 시간대를 Japan 으로 설정하려면 /usr/share/zoneinfo 의 내용을 검사하여 적절한 항목을 찾습니다.

$ ls /usr/share/zoneinfo/ Africa Asia Canada Cuba EST GB GMT-0 HST iso3166.tab Kwajalein MST NZ-CHAT posix right Turkey UTC Zulu America Atlantic CET EET EST5EDT GB-Eire GMT+0 Iceland Israel Libya MST7MDT Pacific posixrules ROC UCT WET Antarctica Australia Chile Egypt Etc GMT Greenwich Indian Jamaica MET Navajo Poland PRC ROK Universal W-SU Arctic Brazil CST6CDT Eire Europe GMT0 Hongkong Iran Japan Mexico NZ Portugal PST8PDT Singapore US zone.tab

위에 나열된 출력에는 표준 시간대 파일과 추가 표준 시간대 파일이 포함된 디렉터리가 포함됩니다. 예를 들어, 일본은 이 결과에서 개별 표준 시간대 파일이지만 아프리카 는 추가 표준 시간대 파일이 포함된 디렉토리입니다.

$ ls /usr/share/zoneinfo/Africa/ Abidjan Algiers Bamako Bissau Bujumbura Ceuta Dar_es_Salaam El_Aaiun Harare Kampala Kinshasa Lome Lusaka Maseru Monrovia Niamey Porto-Novo Tripoli Accra Asmara Bangui Blantyre Cairo Conakry Djibouti Freetown Johannesburg Khartoum Lagos Luanda Malabo Mbabane Nairobi Nouakchott Sao_Tome Tunis Addis_Ababa Asmera Banjul Brazzaville Casablanca Dakar Douala Gaborone Juba Kigali Libreville Lubumbashi Maputo Mogadishu Ndjamena Ouagadougou Timbuktu Windhoek

환경 파일에 항목을 추가하여 시간대를 Japan 로 설정합니다.

parameter_defaults: TimeZone: 'Japan'

3.2. 예 2: 레이어 3 고가용성 비활성화 (L3HA)

OpenStack Networking(neutron) API(puppet/services/neutron-api.yaml)에 대한 Heat 템플릿에는 3개의 고가용성(L3HA)을 활성화 및 비활성화하는 매개변수가 포함되어 있습니다. 매개변수의 기본값은 false 입니다. 그러나 환경 파일에서 다음을 사용하여 활성화할 수 있습니다.

parameter_defaults: NeutronL3HA: true

3.3. 예: Telemetry Dispatcher 구성

OpenStack Telemetry(ceilometer) 서비스에는 시계열 데이터 스토리지(gnocchi)를 위한 구성 요소가 포함되어 있습니다. puppet/services/ceilometer-base.yaml Heat 템플릿을 사용하면 gnocchi 와 표준 데이터베이스를 전환할 수 있습니다. 다음 중 하나로 설정하는 CeilometerMeterDispatcher 매개변수를 사용하여 이 작업을 수행합니다.

-

Gnocchi -Ceilometer 디스패치용 새 시계열 데이터베이스를 사용합니다. 이는 기본 옵션입니다. -

데이터베이스- Ceilometer 디스패처에 표준 데이터베이스를 사용합니다.

표준 데이터베이스로 전환하려면 환경 파일에 다음을 추가합니다.

parameter_defaults: CeilometerMeterDispatcher: database

3.4. 예 4: RabbitMQ 파일 설명자 제한 구성

특정 구성의 경우 RabbitMQ 서버의 파일 설명자 제한을 늘려야 할 수 있습니다. puppet/services/rabbitmq.yaml Heat 템플릿을 사용하면 RabbitFDLimit 매개변수를 필요한 제한으로 설정할 수 있습니다. 환경 파일에 다음을 추가합니다.

parameter_defaults: RabbitFDLimit: 65536

3.5. 예 5: 매개 변수 활성화 및 비활성화

경우에 따라 배포 중에 매개변수를 처음 설정한 다음 업데이트 또는 확장 작업과 같은 향후 배포 작업에 대한 매개 변수를 비활성화해야 할 수 있습니다. 예를 들어 오버클라우드 생성 중에 사용자 지정 RPM을 포함하려면 다음이 포함됩니다.

parameter_defaults: DeployArtifactURLs: ["http://www.example.com/myfile.rpm"]

향후 배포에서 이 매개변수를 비활성화해야 하는 경우 매개변수를 제거하는 것만으로는 충분하지 않습니다. 대신 매개변수를 빈 값으로 설정합니다.

parameter_defaults: DeployArtifactURLs: []

이렇게 하면 후속 배포 작업에 매개변수가 더 이상 설정되지 않습니다.

3.6. 수정할 매개변수 확인

Red Hat OpenStack Platform director는 설정에 필요한 많은 매개 변수를 제공합니다. 경우에 따라 설정할 특정 옵션과 해당 director 매개변수를 식별하는 데 어려움이 있을 수 있습니다. director를 통해 설정할 옵션이 있는 경우 다음 워크플로우를 사용하여 옵션을 확인하고 특정 오버클라우드 매개변수에 매핑합니다.

- 구성할 옵션을 확인합니다. 옵션을 사용하는 서비스를 기록해 둡니다.

이 옵션에 해당하는 Puppet 모듈을 확인합니다. Red Hat OpenStack Platform용 Puppet 모듈은 director 노드의

/etc/puppet/modules에 있습니다. 각 모듈은 특정 서비스에 해당합니다. 예를 들어keystone모듈은 OpenStack Identity(keystone)에 해당합니다.- Puppet 모듈에 선택한 옵션을 제어하는 변수가 포함된 경우 다음 단계로 이동합니다.

- Puppet 모듈에 선택한 옵션을 제어하는 변수가 포함되어 있지 않으면 이 옵션에는 hieradata가 존재하지 않습니다. 가능한 경우 오버클라우드 배포가 완료된 후 옵션을 수동으로 설정할 수 있습니다.

hieradata 형태로 director의 코어 Heat 템플릿 컬렉션을 Puppet 변수에 대한 확인합니다.

puppet/services/*의 템플릿은 일반적으로 동일한 서비스의 Puppet 모듈에 해당합니다. 예를 들어puppet/services/keystone.yaml템플릿은keystone모듈에 hieradata를 제공합니다.- Heat 템플릿이 Puppet 변수에 대해 hieradata를 설정하는 경우 템플릿은 수정할 director 기반 매개변수도 공개해야 합니다.

- Heat 템플릿이 Puppet 변수에 대한 hieradata를 설정하지 않으면 구성 후크를 사용하여 환경 파일을 사용하여 hieradata를 전달합니다. hieradata 사용자 지정에 대한 자세한 내용은 4.5절. “Puppet: 역할에 대한 Hieradata 사용자 지정” 를 참조하십시오.

워크플로 예

OpenStack Identity(keystone)에 대한 알림 형식을 변경해야 할 수 있습니다. 워크플로우를 사용하여 다음을 수행합니다.

-

구성할 OpenStack 매개 변수를 확인합니다(

notification_format). keystonePuppet 모듈에서notification_format설정을 검색합니다. 예를 들면 다음과 같습니다.$ grep notification_format /etc/puppet/modules/keystone/manifests/*

이 경우

keystone모듈은keystone::notification_format변수를 사용하여 이 옵션을 관리합니다.keystone서비스 템플릿에서 이 변수를 검색합니다. 예를 들면 다음과 같습니다.$ grep "keystone::notification_format" /usr/share/openstack-tripleo-heat-templates/puppet/services/keystone.yaml

출력에

keystone::notification_formathieradata를 설정하는 데KeystoneNotificationFormat매개변수를 사용하는 director가 표시됩니다.

다음 표는 최종 매핑을 보여줍니다.

| Director Parameter | Puppet Hieradata | OpenStack Identity(keystone) 옵션 |

|---|---|---|

|

|

|

|

즉, 오버클라우드 환경 파일에서 KeystoneNotificationFormat 을 설정하면 오버클라우드 구성 중에 keystone.conf 파일에 notification_format 옵션이 설정됩니다.

4장. 설정 후크

구성 후크는 자체 구성 기능을 Overcloud 배포 프로세스에 삽입하는 방법을 제공합니다. 여기에는 기본 Overcloud 서비스 구성 및 Puppet 기반 구성을 수정하기 위한 후크 이전 및 이후에 사용자 지정 설정을 삽입하는 후크가 포함됩니다.

4.1. 첫 번째 부팅: 첫 번째 부팅 설정 사용자 지정

director는 Overcloud 초기 생성 시 모든 노드에서 구성을 수행하는 메커니즘을 제공합니다. director는 OS::TripleO::NodeUserData 리소스 유형을 사용하여 호출할 수 있는 cloud-init 를 통해 이를 수행합니다.

이 예제에서는 모든 노드에서 사용자 지정 IP 주소로 네임서버를 업데이트합니다. 먼저 각 노드의 resolv.conf 를 특정 이름 서버에 추가하는 스크립트를 실행하는 기본 heat 템플릿(/home/stack/templates/nameserver.yaml)을 생성해야 합니다. OS::TripleO::MultipartMime 리소스 유형을 사용하여 구성 스크립트를 보낼 수 있습니다.

heat_template_version: 2014-10-16

description: >

Extra hostname configuration

resources:

userdata:

type: OS::Heat::MultipartMime

properties:

parts:

- config: {get_resource: nameserver_config}

nameserver_config:

type: OS::Heat::SoftwareConfig

properties:

config: |

#!/bin/bash

echo "nameserver 192.168.1.1" >> /etc/resolv.conf

outputs:

OS::stack_id:

value: {get_resource: userdata}

다음으로 heat 템플릿을 OS::TripleO::NodeUserData 리소스 유형으로 등록하는 환경 파일(/home/stack/templates/firstboot.yaml)을 생성합니다.

resource_registry: OS::TripleO::NodeUserData: /home/stack/templates/nameserver.yaml

첫 번째 부팅 구성을 추가하려면 Overcloud를 처음 생성할 때 다른 환경 파일과 함께 환경 파일을 스택에 추가합니다. 예를 들면 다음과 같습니다.

$ openstack overcloud deploy --templates \

...

-e /home/stack/templates/firstboot.yaml \

...

-e 는 환경 파일을 Overcloud 스택에 적용합니다.

그러면 처음 생성되어 부팅될 때 모든 노드에 구성이 추가됩니다. Overcloud 스택 업데이트와 같은 이러한 템플릿에 대한 후속 포함은 이 스크립트를 실행하지 않습니다.

OS::TripleO::NodeUserData 만 하나의 heat 템플릿에 등록할 수 있습니다. 이후의 사용은 사용할 heat 템플릿을 덮어씁니다.

4.2. 사전 구성: 특정 Overcloud 역할 사용자 지정

이 문서의 이전 버전에서는 OS::TripleO::Tasks::*PreConfig 리소스를 사용하여 역할에 따라 사전 구성 후크를 제공했습니다. director의 Heat 템플릿 컬렉션에는 이러한 후크를 전용으로 사용해야 하므로 사용자 지정 용도로 사용해서는 안 됩니다. 대신 아래에 설명된 OS::TripleO::*ExtraConfigPre 후크를 사용합니다.

Overcloud는 OpenStack 구성 요소의 핵심 구성에 Puppet을 사용합니다. director는 첫 번째 부팅이 완료된 후 코어 구성이 시작되기 전에 특정 노드 역할에 사용자 정의 구성을 제공하는 후크 세트를 제공합니다. 이러한 후크에는 다음이 포함됩니다.

- OS::TripleO::ControllerExtraConfigPre

- core Puppet을 구성하기 전에 컨트롤러 노드에 추가 구성이 적용됩니다.

- OS::TripleO::ComputeExtraConfigPre

- 코어 Puppet 구성 전에 컴퓨팅 노드에 적용되는 추가 구성입니다.

- OS::TripleO::CephStorageExtraConfigPre

- 코어 Puppet 구성 전에 Ceph Storage 노드에 적용되는 추가 구성입니다.

- OS::TripleO::ObjectStorageExtraConfigPre

- 코어 Puppet 구성 전에 Object Storage 노드에 적용되는 추가 구성입니다.

- OS::TripleO::BlockStorageExtraConfigPre

- 코어 Puppet 구성 전에 Block Storage 노드에 적용되는 추가 구성입니다.

- OS::TripleO::[ROLE]ExtraConfigPre

-

core Puppet 구성 전에 사용자 지정 노드에 적용되는 추가 구성입니다.

[ROLE]을 구성 가능 역할 이름으로 바꿉니다.

이 예제에서는 먼저 변수 이름 서버가 있는 노드의 resolv.conf 에 쓰는 스크립트를 실행하는 기본 heat 템플릿(/home/stack/templates/nameserver.yaml)을 생성합니다.

heat_template_version: 2014-10-16

description: >

Extra hostname configuration

parameters:

server:

type: string

nameserver_ip:

type: string

DeployIdentifier:

type: string

resources:

CustomExtraConfigPre:

type: OS::Heat::SoftwareConfig

properties:

group: script

config:

str_replace:

template: |

#!/bin/sh

echo "nameserver _NAMESERVER_IP_" > /etc/resolv.conf

params:

_NAMESERVER_IP_: {get_param: nameserver_ip}

CustomExtraDeploymentPre:

type: OS::Heat::SoftwareDeployment

properties:

server: {get_param: server}

config: {get_resource: CustomExtraConfigPre}

actions: ['CREATE','UPDATE']

input_values:

deploy_identifier: {get_param: DeployIdentifier}

outputs:

deploy_stdout:

description: Deployment reference, used to trigger pre-deploy on changes

value: {get_attr: [CustomExtraDeploymentPre, deploy_stdout]}

이 예제에서 resources 섹션에는 다음이 포함됩니다.

- CustomExtraConfigPre

-

이는 소프트웨어 구성을 정의합니다. 이 예제에서는 Bash

스크립트를 정의하고 Heat에서_NAMESERVER_IP_를nameserver_ip매개변수에 저장된 값으로 교체합니다. - CustomExtraDeploymentPre

이렇게 하면

CustomExtraConfigPre리소스에서 소프트웨어 구성인 소프트웨어 구성이 실행됩니다. 다음을 확인합니다.-

config매개변수는CustomExtraConfigPre리소스에 대한 참조를 제공하므로 Heat는 적용할 구성을 알고 있습니다. -

server매개변수는 Overcloud 노드의 맵을 검색합니다. 이 매개변수는 상위 템플릿에서 제공하며 이 후크의 템플릿에서 필요합니다. -

actions매개변수는 구성을 적용할 시기를 정의합니다. 이 경우 Overcloud가 생성된 경우에만 설정을 적용합니다. 가능한 작업에는CREATE,UPDATE,DELETE,SUSPEND,RESUME가 포함됩니다. -

input_values에는deploy_identifier라는 매개변수가 포함되어 있으며, 이 매개변수는 상위 템플릿의DeployIdentifier를 저장합니다. 이 매개변수는 각 배포 업데이트의 리소스에 타임스탬프를 제공합니다. 이렇게 하면 후속 오버클라우드 업데이트에서 리소스가 얻을 수 있습니다.

-

다음으로 heat 템플릿을 역할 기반 리소스 유형에 등록하는 환경 파일(/home/stack/templates/pre_config.yaml)을 생성합니다. 예를 들어 컨트롤러 노드에만 적용하려면 ControllerExtraConfigPre 후크를 사용합니다.

resource_registry: OS::TripleO::ControllerExtraConfigPre: /home/stack/templates/nameserver.yaml parameter_defaults: nameserver_ip: 192.168.1.1

설정을 적용하려면 Overcloud를 생성하거나 업데이트할 때 다른 환경 파일과 함께 환경 파일을 스택에 추가합니다. 예를 들면 다음과 같습니다.

$ openstack overcloud deploy --templates \

...

-e /home/stack/templates/pre_config.yaml \

...이는 코어 구성이 초기 Overcloud 생성 또는 후속 업데이트에서 시작되기 전에 모든 컨트롤러 노드에 적용됩니다.

각 리소스를 후크당 하나의 Heat 템플릿에만 등록할 수 있습니다. 이후의 사용은 사용할 Heat 템플릿을 덮어씁니다.

4.3. 사전 구성: 모든 오버클라우드 역할 사용자 지정

Overcloud는 OpenStack 구성 요소의 핵심 구성에 Puppet을 사용합니다. director는 첫 번째 부팅 후 및 코어 구성이 시작되기 전에 모든 노드 유형을 구성하는 후크를 제공합니다.

- OS::TripleO::NodeExtraConfig

- core Puppet 구성보다 먼저 모든 노드 역할에 적용되는 추가 구성입니다.

이 예제에서는 먼저 스크립트를 실행하여 각 노드의 resolv.conf 를 변수 이름 서버에 추가하는 기본 heat 템플릿(/home/stack/templates/nameserver.yaml)을 생성합니다.

heat_template_version: 2014-10-16

description: >

Extra hostname configuration

parameters:

server:

type: string

nameserver_ip:

type: string

DeployIdentifier:

type: string

resources:

CustomExtraConfigPre:

type: OS::Heat::SoftwareConfig

properties:

group: script

config:

str_replace:

template: |

#!/bin/sh

echo "nameserver _NAMESERVER_IP_" >> /etc/resolv.conf

params:

_NAMESERVER_IP_: {get_param: nameserver_ip}

CustomExtraDeploymentPre:

type: OS::Heat::SoftwareDeployment

properties:

server: {get_param: server}

config: {get_resource: CustomExtraConfigPre}

actions: ['CREATE','UPDATE']

input_values:

deploy_identifier: {get_param: DeployIdentifier}

outputs:

deploy_stdout:

description: Deployment reference, used to trigger pre-deploy on changes

value: {get_attr: [CustomExtraDeploymentPre, deploy_stdout]}

이 예제에서 resources 섹션에는 다음이 포함됩니다.

- CustomExtraConfigPre

-

이는 소프트웨어 구성을 정의합니다. 이 예제에서는 Bash

스크립트를 정의하고 Heat에서_NAMESERVER_IP_를nameserver_ip매개변수에 저장된 값으로 교체합니다. - CustomExtraDeploymentPre

이렇게 하면

CustomExtraConfigPre리소스에서 소프트웨어 구성인 소프트웨어 구성이 실행됩니다. 다음을 확인합니다.-

config매개변수는CustomExtraConfigPre리소스에 대한 참조를 제공하므로 Heat는 적용할 구성을 알고 있습니다. -

server매개변수는 Overcloud 노드의 맵을 검색합니다. 이 매개변수는 상위 템플릿에서 제공하며 이 후크의 템플릿에서 필요합니다. -

actions매개변수는 구성을 적용할 시기를 정의합니다. 이 경우 Overcloud가 생성된 경우에만 설정을 적용합니다. 가능한 작업에는CREATE,UPDATE,DELETE,SUSPEND,RESUME가 포함됩니다. -

input_values매개변수에는deploy_identifier라는 하위 매개변수가 포함되어 있으며, 이 매개변수는 상위 템플릿의DeployIdentifier를 저장합니다. 이 매개변수는 각 배포 업데이트의 리소스에 타임스탬프를 제공합니다. 이렇게 하면 후속 오버클라우드 업데이트에서 리소스가 얻을 수 있습니다.

-

다음으로 heat 템플릿을 OS::TripleO::NodeExtraConfig 리소스 유형으로 등록하는 환경 파일(/home/stack/templates/pre_config.yaml)을 생성합니다.

resource_registry: OS::TripleO::NodeExtraConfig: /home/stack/templates/nameserver.yaml parameter_defaults: nameserver_ip: 192.168.1.1

설정을 적용하려면 Overcloud를 생성하거나 업데이트할 때 다른 환경 파일과 함께 환경 파일을 스택에 추가합니다. 예를 들면 다음과 같습니다.

$ openstack overcloud deploy --templates \

...

-e /home/stack/templates/pre_config.yaml \

...이는 코어 구성이 초기 Overcloud 생성 또는 후속 업데이트에서 시작되기 전에 모든 노드에 적용됩니다.

OS::TripleO::NodeExtraConfig 만 하나의 Heat 템플릿에 등록할 수 있습니다. 이후의 사용은 사용할 Heat 템플릿을 덮어씁니다.

4.4. 구성 후: 모든 오버클라우드 역할 사용자 지정

이 문서의 이전 버전에서는 OS::TripleO::Tasks::*PostConfig 리소스를 사용하여 역할별로 구성 후 후크를 제공했습니다. director의 Heat 템플릿 컬렉션에는 이러한 후크를 전용으로 사용해야 하므로 사용자 지정 용도로 사용해서는 안 됩니다. 대신 아래에 설명된 OS::TripleO::NodeExtraConfigPost 후크를 사용합니다.

Overcloud 생성을 완료했지만 초기 생성 또는 Overcloud 후속 업데이트 시 모든 역할에 구성을 추가하려는 상황이 발생할 수 있습니다. 이 경우 다음과 같은 구성 후 후크를 사용합니다.

- OS::TripleO::NodeExtraConfigPost

- 코어 Puppet 구성 후 모든 노드 역할에 적용되는 추가 구성입니다.

이 예제에서는 먼저 스크립트를 실행하여 각 노드의 resolv.conf 를 변수 이름 서버에 추가하는 기본 heat 템플릿(/home/stack/templates/nameserver.yaml)을 생성합니다.

heat_template_version: 2014-10-16

description: >

Extra hostname configuration

parameters:

servers:

type: json

nameserver_ip:

type: string

DeployIdentifier:

type: string

resources:

CustomExtraConfig:

type: OS::Heat::SoftwareConfig

properties:

group: script

config:

str_replace:

template: |

#!/bin/sh

echo "nameserver _NAMESERVER_IP_" >> /etc/resolv.conf

params:

_NAMESERVER_IP_: {get_param: nameserver_ip}

CustomExtraDeployments:

type: OS::Heat::SoftwareDeploymentGroup

properties:

servers: {get_param: servers}

config: {get_resource: CustomExtraConfig}

actions: ['CREATE','UPDATE']

input_values:

deploy_identifier: {get_param: DeployIdentifier}

이 예제에서 resources 섹션에는 다음이 포함됩니다.

- CustomExtraConfig

-

이는 소프트웨어 구성을 정의합니다. 이 예제에서는 Bash

스크립트를 정의하고 Heat에서_NAMESERVER_IP_를nameserver_ip매개변수에 저장된 값으로 교체합니다. - CustomExtraDeployments

이렇게 하면

CustomExtraConfig리소스에서 소프트웨어 구성인 소프트웨어 구성이 실행됩니다. 다음을 확인합니다.-

config매개변수는CustomExtraConfig리소스에 대한 참조를 제공하므로 Heat는 적용할 구성을 알고 있습니다. -

servers매개변수는 Overcloud 노드의 맵을 검색합니다. 이 매개변수는 상위 템플릿에서 제공하며 이 후크의 템플릿에서 필요합니다. -

actions매개변수는 구성을 적용할 시기를 정의합니다. 이 경우 Overcloud가 생성된 경우에만 설정을 적용합니다. 가능한 작업에는CREATE,UPDATE,DELETE,SUSPEND,RESUME가 포함됩니다. -

input_values에는deploy_identifier라는 매개변수가 포함되어 있으며, 이 매개변수는 상위 템플릿의DeployIdentifier를 저장합니다. 이 매개변수는 각 배포 업데이트의 리소스에 타임스탬프를 제공합니다. 이렇게 하면 후속 오버클라우드 업데이트에서 리소스가 얻을 수 있습니다.

-

다음으로 heat 템플릿을 OS::TripleO::NodeExtraConfigPost: 리소스 유형으로 등록하는 환경 파일(/home/stack/templates/post_config.yaml)을 생성합니다.

resource_registry: OS::TripleO::NodeExtraConfigPost: /home/stack/templates/nameserver.yaml parameter_defaults: nameserver_ip: 192.168.1.1

설정을 적용하려면 Overcloud를 생성하거나 업데이트할 때 다른 환경 파일과 함께 환경 파일을 스택에 추가합니다. 예를 들면 다음과 같습니다.

$ openstack overcloud deploy --templates \

...

-e /home/stack/templates/post_config.yaml \

...이는 코어 구성이 초기 Overcloud 생성 또는 후속 업데이트에서 완료된 후 모든 노드에 적용됩니다.

OS::TripleO::NodeExtraConfigPost 만 하나의 Heat 템플릿에 등록할 수 있습니다. 이후의 사용은 사용할 Heat 템플릿을 덮어씁니다.

4.5. Puppet: 역할에 대한 Hieradata 사용자 지정

Heat 템플릿 컬렉션에는 특정 노드 유형에 추가 구성을 전달하는 매개변수 세트가 포함되어 있습니다. 이러한 매개변수는 노드의 Puppet 구성에 대한 설정을 hieradata로 저장합니다. 이러한 매개변수는 다음과 같습니다.

- ControllerExtraConfig

- 모든 컨트롤러 노드에 추가할 구성입니다.

- NovaComputeExtraConfig

- 모든 컴퓨팅 노드에 추가할 구성입니다.

- BlockStorageExtraConfig

- 모든 Block Storage 노드에 추가할 구성입니다.

- ObjectStorageExtraConfig

- 모든 Object Storage 노드에 추가할 구성

- CephStorageExtraConfig

- 모든 Ceph Storage 노드에 추가할 구성

- [ROLE]ExtraConfig

-

구성 가능 역할에 추가할 구성입니다.

[ROLE]을 구성 가능 역할 이름으로 바꿉니다. - ExtraConfig

- 모든 노드에 추가할 구성입니다.

배포 후 구성 프로세스에 구성을 추가하려면 parameter_defaults 섹션에 이러한 매개변수가 포함된 환경 파일을 생성합니다. 예를 들어 컴퓨팅 호스트의 예약된 메모리를 1024MB로 늘리고 VNC 키맵을 일본어로 설정하려면 다음을 수행합니다.

parameter_defaults:

NovaComputeExtraConfig:

nova::compute::reserved_host_memory: 1024

nova::compute::vnc_keymap: ja

openstack overcloud deploy 를 실행하는 경우 이 환경 파일을 포함합니다.

각 매개변수는 한 번만 정의할 수 있습니다. 이후의 사용은 이전 값을 덮어씁니다.

4.6. Puppet: 개별 노드의 Hieradata 사용자 지정

Heat 템플릿 컬렉션을 사용하여 개별 노드에 대해 Puppet hieradata를 설정할 수 있습니다. 이를 수행하려면 노드의 인트로스펙션 데이터 일부로 저장된 시스템 UUID를 가져와야 합니다.

$ openstack baremetal introspection data save 9dcc87ae-4c6d-4ede-81a5-9b20d7dc4a14 | jq .extra.system.product.uuid

그러면 시스템 UUID가 출력됩니다. 예를 들면 다음과 같습니다.

"F5055C6C-477F-47FB-AFE5-95C6928C407F"

노드별 hieradata를 정의하는 환경 파일에서 이 시스템 UUID를 사용하고 per_node.yaml 템플릿을 사전 구성 후크에 등록합니다. 예를 들면 다음과 같습니다.

resource_registry:

OS::TripleO::ComputeExtraConfigPre: /usr/share/openstack-tripleo-heat-templates/puppet/extraconfig/pre_deploy/per_node.yaml

parameter_defaults:

NodeDataLookup: '{"F5055C6C-477F-47FB-AFE5-95C6928C407F": {"nova::compute::vcpu_pin_set": [ "2", "3" ]}}'

openstack overcloud deploy 를 실행하는 경우 이 환경 파일을 포함합니다.

per_node.yaml 템플릿은 각 시스템 UUID에 해당하는 노드에 heiradata 파일 세트를 생성하고 사용자가 정의한 hieradata를 포함합니다. UUID가 정의되지 않은 경우 결과 hieradata 파일이 비어 있습니다. 이전 예에서 per_node.yaml 템플릿은 OS::TripleO::ComputeExtraConfigPre 후크에 따라 모든 컴퓨팅 노드에서 실행되지만 시스템 UUID F5055C6C-477F-47FB-AFE5-9528C407F 가 hieradata를 수신하는 컴퓨팅 노드만 사용됩니다.

이를 통해 각 노드를 특정 요구 사항에 맞게 조정할 수 있습니다.

4.7. Puppet: 사용자 정의 매니페스트 적용

경우에 따라 Overcloud 노드에 일부 추가 구성 요소를 설치하고 구성해야 할 수 있습니다. 기본 구성이 완료된 후 노드에 적용되는 사용자 정의 Puppet 매니페스트를 사용하여 이를 수행할 수 있습니다. 기본 예로 각 노드에 motd 를 설치할 수 있습니다. 수행 프로세스는 먼저 Puppet 구성을 시작하는 Heat 템플릿(/home/stack/templates/custom_puppet_config.yaml)을 생성하는 것입니다.

heat_template_version: 2014-10-16

description: >

Run Puppet extra configuration to set new MOTD

parameters:

servers:

type: json

resources:

ExtraPuppetConfig:

type: OS::Heat::SoftwareConfig

properties:

config: {get_file: motd.pp}

group: puppet

options:

enable_hiera: True

enable_facter: False

ExtraPuppetDeployments:

type: OS::Heat::SoftwareDeploymentGroup

properties:

config: {get_resource: ExtraPuppetConfig}

servers: {get_param: servers}

여기에는 템플릿 내에 /home/stack/templates/motd.pp 가 포함되어 구성을 위해 노드에 전달합니다. motd.pp 파일 자체에는 motd 를 설치하고 구성하는 Puppet 클래스가 포함되어 있습니다.

다음으로 heat 템플릿을 OS::TripleO::NodeExtraConfigPost: 리소스 유형으로 등록하는 환경 파일(/home/stack/templates/puppet_post_config.yaml)을 생성합니다.

resource_registry: OS::TripleO::NodeExtraConfigPost: /home/stack/templates/custom_puppet_config.yaml

마지막으로 Overcloud 스택을 생성하거나 업데이트할 때 다른 환경 파일과 함께 이 환경 파일을 포함합니다.

$ openstack overcloud deploy --templates \

...

-e /home/stack/templates/puppet_post_config.yaml \

...

이는 motd.pp 의 설정을 Overcloud의 모든 노드에 적용합니다.

5장. 오버클라우드 등록

Overcloud는 Red Hat Content Delivery Network, Red Hat Satellite 5 서버 또는 Red Hat Satellite 6 서버에 노드를 등록할 수 있는 방법을 제공합니다.

5.1. 환경 파일을 사용하여 오버클라우드 등록

Heat 템플릿 컬렉션에서 등록 파일을 복사합니다.

$ cp -r /usr/share/openstack-tripleo-heat-templates/extraconfig/pre_deploy/rhel-registration ~/templates/.

~/templates/rhel-registration/environment-rhel-registration.yaml 을 편집하고 등록 방법 및 세부 정보에 맞게 다음 값을 수정합니다.

- rhel_reg_method

-

등록 방법을 선택합니다.

포털,satellite또는disable. - rhel_reg_type

-

등록할 단위 유형입니다.

시스템으로등록하려면 비워 두십시오. - rhel_reg_auto_attach

-

이 시스템에 호환되는 서브스크립션을 자동으로 연결합니다. 활성화하려면

true로 설정합니다. 이 기능을 비활성화하려면 환경 파일에서 이 매개변수를 제거합니다. - rhel_reg_service_level

- 자동 연결에 사용할 서비스 수준입니다.

- rhel_reg_release

- 자동 연결의 릴리스 버전을 설정하려면 이 매개변수를 사용합니다. Red Hat Subscription Manager의 기본값을 사용하려면 비워 두십시오.

- rhel_reg_pool_id

-

사용할 서브스크립션 풀 ID입니다. 자동 연결하지 않는 경우 이 값을 사용합니다. 이 ID를 찾으려면 언더클라우드 노드에서

sudo subscription-manager list --available --all --matches="*OpenStack*"을 실행하고 결과Pool ID값을 사용합니다. - rhel_reg_sat_url

-

오버클라우드 노드를 등록할 Satellite 서버의 기본 URL입니다. Satellite의 HTTPS URL 대신 HTTP URL을 이 매개변수에 사용합니다. 예를 들어 https://satellite.example.com 대신 http://satellite.example.com을 사용합니다. Overcloud 생성 프로세스에서는 이 URL을 사용하여 서버가 Red Hat Satellite 5 서버인지 또는 Red Hat Satellite 6 서버인지 확인합니다. Red Hat Satellite 6 서버인 경우 Overcloud는

katello-ca-consumer-latest.noarch.rpm파일을 가져오고subscription-manager에 등록한 다음katello-agent를 설치합니다. Red Hat Satellite 5 서버의 경우 Overcloud는RHN-ORG-TRUSTED-SSL-CERT파일을 가져오고rhnreg_ks에 등록합니다. - rhel_reg_server_url

- 사용할 서브스크립션 서비스의 호스트 이름입니다. 고객 포털 서브스크립션 관리의 기본값은 subscription.rhn.redhat.com입니다. 이 옵션을 사용하지 않으면 시스템이 고객 포털 서브스크립션 관리에 등록됩니다. 서브스크립션 서버 URL은 https://hostname:port/prefix 의 형식을 사용합니다.

- rhel_reg_base_url

- 업데이트를 수신하는 데 사용할 콘텐츠 전달 서버의 호스트 이름을 지정합니다. 기본값은 https://cdn.redhat.com 입니다. Satellite 6은 자체 콘텐츠를 호스팅하므로 Satellite 6에 등록된 시스템에 URL을 사용해야 합니다. 콘텐츠의 기본 URL은 https://hostname:port/prefix 의 형식을 사용합니다.

- rhel_reg_org

-

등록에 사용하는 조직입니다. 이 ID를 찾으려면 언더클라우드 노드에서

sudo subscription-manager orgs를 실행합니다. 메시지가 표시되면 Red Hat 자격 증명을 입력하고 결과Key값을 사용합니다. - rhel_reg_environment

- 선택한 조직 내에서 사용할 환경입니다.

- rhel_reg_repos

- 활성화할 리포지토리 목록입니다.

- rhel_reg_activation_key

- 등록에 사용할 활성화 키입니다.

- rhel_reg_user; rhel_reg_password

- 등록에 사용할 사용자 이름 및 암호입니다. 가능한 경우 등록에 활성화 키를 사용합니다.

- rhel_reg_machine_name

- 시스템 이름입니다. 노드의 호스트 이름을 사용하려면 이 값을 비워 둡니다.

- rhel_reg_force

-

등록 옵션을 강제 적용하려면

true로 설정합니다. 예를 들어 노드를 다시 등록할 때입니다. - rhel_reg_sat_repo

-

katello-agent와 같은 Red Hat Satellite 6의 관리 툴이 포함된 리포지토리입니다. 올바른 리포지토리 이름이 Red Hat Satellite 버전에 해당하는지 확인하고 리포지토리가 Satellite 서버에 동기화되었는지 확인합니다. 예를 들어rhel-7-server-satellite-tools-6.2-rpms는 Red Hat Satellite 6.2에 해당합니다.

배포 명령(openstack overcloud deploy)은 -e 옵션을 사용하여 환경 파일을 추가합니다. ~/templates/rhel-registration/environment-rhel-registration.yaml 및 ~/templates/rhel-registration/rhel-registration-resource-registry.yaml 을 모두 추가합니다. 예를 들면 다음과 같습니다.

$ openstack overcloud deploy --templates [...] -e /home/stack/templates/rhel-registration/environment-rhel-registration.yaml -e /home/stack/templates/rhel-registration/rhel-registration-resource-registry.yaml

등록은 OS::TripleO::NodeExtraConfig Heat 리소스로 설정됩니다. 즉, 등록에만 이 리소스를 사용할 수 있습니다. 자세한 내용은 4.2절. “사전 구성: 특정 Overcloud 역할 사용자 지정”를 참조하십시오.

5.2. 예: 고객 포털에 등록

다음에서는 my-openstack 활성화 키를 사용하여 오버클라우드 노드를 Red Hat 고객 포털에 등록하고 1a85f9223e3d5e43013e3d6e8ff506fd 풀에 등록합니다.

parameter_defaults: rhel_reg_auto_attach: "" rhel_reg_activation_key: "my-openstack" rhel_reg_org: "1234567" rhel_reg_pool_id: "1a85f9223e3d5e43013e3d6e8ff506fd" rhel_reg_repos: "rhel-7-server-rpms,rhel-7-server-extras-rpms,rhel-7-server-rh-common-rpms,rhel-ha-for-rhel-7-server-rpms,rhel-7-server-openstack-10-rpms,rhel-7-server-rhceph-2-osd-rpms,rhel-7-server-rhceph-2-mon-rpms,rhel-7-server-rhceph-2-tools-rpms" rhel_reg_method: "portal" rhel_reg_sat_repo: "" rhel_reg_base_url: "" rhel_reg_environment: "" rhel_reg_force: "" rhel_reg_machine_name: "" rhel_reg_password: "" rhel_reg_release: "7.7" rhel_reg_sat_url: "" rhel_reg_server_url: "" rhel_reg_service_level: "" rhel_reg_user: "" rhel_reg_type: "" rhel_reg_http_proxy_host: "" rhel_reg_http_proxy_port: "" rhel_reg_http_proxy_username: "" rhel_reg_http_proxy_password: ""

5.3. 예: Red Hat Satellite 6 Server 등록

다음에서는 overcloud 노드를 sat6.example.com의 Red Hat Satellite 6 Server에 등록하고 my-openstack 활성화 키를 사용하여 1a85f9223e3d5e43013e3d6e8ff506fd 풀에 등록합니다. 이 경우 활성화 키는 활성화할 리포지토리도 제공합니다.

parameter_defaults: rhel_reg_activation_key: "my-openstack" rhel_reg_org: "1" rhel_reg_pool_id: "1a85f9223e3d5e43013e3d6e8ff506fd" rhel_reg_method: "satellite" rhel_reg_sat_url: "http://sat6.example.com" rhel_reg_sat_repo: "rhel-7-server-satellite-tools-6.2-rpms" rhel_reg_repos: "" rhel_reg_auto_attach: "" rhel_reg_base_url: "" rhel_reg_environment: "" rhel_reg_force: "" rhel_reg_machine_name: "" rhel_reg_password: "" rhel_reg_release: "7.7" rhel_reg_server_url: "" rhel_reg_service_level: "" rhel_reg_user: "" rhel_reg_type: "" rhel_reg_http_proxy_host: "" rhel_reg_http_proxy_port: "" rhel_reg_http_proxy_username: "" rhel_reg_http_proxy_password: ""

5.4. 예: Red Hat Satellite 5 Server 등록

다음에서는 overcloud 노드를 sat5.example.com의 Red Hat Satellite 5 Server에 등록하고 my-openstack 활성화 키를 사용하고 서브스크립션을 자동으로 연결합니다. 이 경우 활성화 키는 활성화할 리포지토리도 제공합니다.

parameter_defaults: rhel_reg_auto_attach: "" rhel_reg_activation_key: "my-openstack" rhel_reg_org: "1" rhel_reg_method: "satellite" rhel_reg_sat_url: "http://sat5.example.com" rhel_reg_repos: "" rhel_reg_base_url: "" rhel_reg_environment: "" rhel_reg_force: "" rhel_reg_machine_name: "" rhel_reg_password: "" rhel_reg_pool_id: "" rhel_reg_release: "7.7" rhel_reg_server_url: "" rhel_reg_service_level: "" rhel_reg_user: "" rhel_reg_type: "" rhel_reg_sat_repo: "" rhel_reg_http_proxy_host: "" rhel_reg_http_proxy_port: "" rhel_reg_http_proxy_username: "" rhel_reg_http_proxy_password: ""

6장. 구성 가능 서비스 및 사용자 정의 역할

Overcloud는 일반적으로 컨트롤러 노드, 컴퓨팅 노드 및 다른 스토리지 노드 유형과 같은 사전 정의된 역할의 노드로 구성됩니다. 이러한 각 기본 역할에는 director 노드의 코어 Heat 템플릿 컬렉션에 정의된 서비스 세트가 포함되어 있습니다. 그러나 코어 Heat 템플릿의 아키텍처는 다음과 같은 방법을 제공합니다.

- 사용자 정의 역할 생성

- 각 역할에서 서비스 추가 및 제거

이 장에서는 사용자 정의 역할, 구성 가능 서비스 및 사용 방법의 아키텍처를 살펴봅니다.

지침 및 제한 사항

구성 가능 노드 아키텍처에 대한 다음 지침 및 제한 사항에 유의하십시오.

-

지원되는 독립 실행형 사용자 지정 역할에

systemd관리 서비스를 할당할 수 있습니다. - Pacemaker 관리 서비스를 분할할 수 없습니다. Pacemaker에서 Overcloud 클러스터 내의 각 노드에서 동일한 서비스 세트를 관리하기 때문입니다. Pacemaker 관리 서비스를 분할하면 클러스터 배포 오류가 발생할 수 있습니다. 이러한 서비스는 컨트롤러 역할에 남아 있어야 합니다.

- Red Hat OpenStack Platform 9에서 10으로 업그레이드하는 동안 사용자 정의 역할 및 구성 가능 서비스로 변경할 수 없습니다. 업그레이드 스크립트는 기본 Overcloud 역할만 수용할 수 있습니다.

- 초기 배포 후 추가 사용자 지정 역할을 생성하고 이를 배포하여 기존 서비스를 확장할 수 있습니다.

- Overcloud를 배포한 후에는 어떤 역할의 서비스 목록을 수정할 수 없습니다. Overcloud 배포 후 서비스 목록을 수정하면 배포 오류가 발생하고 노드에서 고립된 서비스를 남겨 둘 수 있습니다.

지원되는 사용자 지정 역할 아키텍처

사용자 지정 역할 및 구성 가능 서비스는 Red Hat OpenStack Platform 10의 새로운 기능이며 제한된 수의 구성 가능 서비스 조합만 이 초기 단계에서 테스트하고 검증되었습니다. Red Hat은 사용자 정의 역할 및 구성 가능 서비스를 사용할 때 다음 아키텍처를 지원합니다.

- 아키텍처 1 -ECDHElithic Controller

- 모든 컨트롤러 서비스는 하나의 컨트롤러 역할에 포함됩니다. 이는 기본값입니다. 자세한 내용은 6.8절. “서비스 아키텍처:ECDHElithic Controller”를 참조하십시오.

- 아키텍처 2 - 분할 컨트롤러

컨트롤러 서비스는 다음 두 가지 역할로 나뉩니다.

- 컨트롤러 PCMK - 데이터베이스 및 로드 밸런싱과 같은 코어 Pacemaker 관리 서비스

- Controller Systemd - 'systemd' 관리형 OpenStack Platform 서비스

자세한 내용은 6.9절. “서비스 아키텍처: 분할 컨트롤러”를 참조하십시오.

- 아키텍처 3 - 독립 실행형 역할

- 아키텍처 1 또는 아키텍처 2를 사용하지만 OpenStack Platform 서비스를 사용자 정의 역할로 분할합니다. 자세한 내용은 6.10절. “서비스 아키텍처: 독립 실행형 역할”를 참조하십시오.

6.1. 사용자 정의 역할 아키텍처 검사

Overcloud 생성 프로세스는 역할 데이터가 포함된 템플릿을 사용하여 역할을 정의합니다. 기본 템플릿은 /usr/share/openstack-tripleo-heat-templates/roles_data.yaml 에 있으며 Controller,Compute,BlockStorage,ObjectStorage, CephStorage 와 같은 모든 기본 역할 유형을 정의합니다.

사용자 지정 roles_data.yaml 파일을 생성하는 경우 Controller 역할이 항상 첫 번째 역할이어야 합니다. 이 역할은 기본 역할로 취급됩니다.

각 역할에는 다음 매개변수가 포함되어 있습니다.

- name

-

(필수) 역할의 이름, 공백이나 특수 문자가 없는 일반 텍스트 이름입니다. 선택한 이름이 다른 리소스와 충돌하지 않는지 확인합니다. 예를 들어 네트워크 대신

Networker - CountDefault

- (선택 사항) 이 역할에 배포할 기본 노드 수를 정의합니다.

- HostnameFormatDefault

(선택 사항) 역할의 기본 호스트 이름 형식을 정의합니다. 기본 이름 지정 규칙은 다음 형식을 사용합니다.

[STACK NAME]-[ROLE NAME]-[NODE ID]

예를 들어 기본 컨트롤러 노드의 이름은 다음과 같습니다.

overcloud-controller-0 overcloud-controller-1 overcloud-controller-2 ...

- ServicesDefault

- (선택 사항) 노드에 포함할 기본 서비스 목록을 정의합니다. 자세한 내용은 6.2절. “Composable Service Architecture 검사”를 참조하십시오.

이러한 옵션은 새 역할을 생성하고 포함할 서비스를 정의하는 수단을 제공합니다.

openstack overcloud deploy 명령은 roles_data.yaml 파일의 매개변수를 overcloud.j2.yaml Heat 템플릿에 통합합니다. 특정 시점에서 overcloud.j2.yaml Heat 템플릿은 roles_data.yaml 에서 역할 목록을 반복하고 각 역할과 관련된 매개변수와 리소스를 생성합니다.

예를 들어 overcloud.j2.yaml Heat 템플릿의 각 역할에 대한 리소스 정의는 다음 스니펫으로 표시됩니다.

{{role.name}}:

type: OS::Heat::ResourceGroup

depends_on: Networks

properties:

count: {get_param: {{role.name}}Count}

removal_policies: {get_param: {{role.name}}RemovalPolicies}

resource_def:

type: OS::TripleO::{{role.name}}

properties:

CloudDomain: {get_param: CloudDomain}

ServiceNetMap: {get_attr: [ServiceNetMap, service_net_map]}

EndpointMap: {get_attr: [EndpointMap, endpoint_map]}

...

이 스니펫에서는 Jinja2 기반 템플릿이 {{role.name}} 변수를 통합하여 각 역할의 이름을 OS::Heat::ResourceGroup 리소스로 정의하는 방법을 보여줍니다. 차례로 roles_data.yaml 의 각 name 매개변수를 사용하여 각 OS::Heat::ResourceGroup 리소스의 이름을 지정합니다.

6.2. Composable Service Architecture 검사

코어 Heat 템플릿 컬렉션에는 puppet/services 하위 디렉터리에 있는 구성 가능 서비스 템플릿 컬렉션이 포함되어 있습니다. 다음 명령을 사용하여 이러한 서비스를 볼 수 있습니다.

$ ls /usr/share/openstack-tripleo-heat-templates/puppet/services

각 서비스 템플릿에는 목적을 식별하는 설명이 포함되어 있습니다. 예를 들어 keystone.yaml 서비스 템플릿에는 다음 설명이 포함되어 있습니다.

description: > OpenStack Identity (`keystone`) service configured with Puppet

이러한 서비스 템플릿은 Red Hat OpenStack Platform 배포와 관련된 리소스로 등록됩니다. 즉, overcloud-resource-registry-puppet.j2.yaml 파일에 정의된 고유한 Heat 리소스 네임스페이스를 사용하여 각 리소스를 호출할 수 있습니다. 모든 서비스는 리소스 유형에 OS::TripleO::Services 네임스페이스를 사용합니다. 예를 들어 keystone.yaml 서비스 템플릿은 OS::TripleO::Services::Keystone 리소스 유형에 등록됩니다.

grep "OS::TripleO::Services::Keystone" /usr/share/openstack-tripleo-heat-templates/overcloud-resource-registry-puppet.j2.yaml OS::TripleO::Services::Keystone: puppet/services/keystone.yaml

overcloud.j2.yaml Heat 템플릿에는 roles_data.yaml 파일에서 각 사용자 지정 역할에 대한 서비스 목록을 정의하는 Jinja2 기반 코드의 섹션이 포함되어 있습니다.

{{role.name}}Services:

description: A list of service resources (configured in the Heat

resource_registry) which represent nested stacks

for each service that should get installed on the {{role.name}} role.

type: comma_delimited_list

default: {{role.ServicesDefault|default([])}}

기본 역할의 경우 ControllerServices,ComputeServices,BlockStorageServices,ObjectStorageServices, CephStorageServices , CephStorageServices 등의 서비스 목록 매개변수가 생성됩니다.

roles_data.yaml 파일에서 각 사용자 지정 역할에 대한 기본 서비스를 정의합니다. 예를 들어 default Controller 역할에는 다음 내용이 포함됩니다.

- name: Controller

CountDefault: 1

ServicesDefault:

- OS::TripleO::Services::CACerts

- OS::TripleO::Services::CephMon

- OS::TripleO::Services::CephExternal

- OS::TripleO::Services::CephRgw

- OS::TripleO::Services::CinderApi

- OS::TripleO::Services::CinderBackup

- OS::TripleO::Services::CinderScheduler

- OS::TripleO::Services::CinderVolume

- OS::TripleO::Services::Core

- OS::TripleO::Services::Kernel

- OS::TripleO::Services::Keystone

- OS::TripleO::Services::GlanceApi

- OS::TripleO::Services::GlanceRegistry

...

그런 다음 이러한 서비스는 ControllerServices 매개변수의 기본 목록으로 정의됩니다.

환경 파일을 사용하여 서비스 매개변수의 기본 목록을 덮어쓸 수도 있습니다. 예를 들어, ControllerServices 를 환경 파일에서 parameter_default 로 정의하여 roles_data.yaml 파일의 서비스 목록을 덮어쓸 수 있습니다.

6.3. Disabled 서비스 활성화

일부 서비스는 기본적으로 비활성화되어 있습니다. 이러한 서비스는 overcloud-resource-registry-puppet.j2.yaml 파일에 null 작업(OS::Heat::None)으로 등록됩니다. 예를 들어 Block Storage 백업 서비스(cinder-backup)는 비활성화되어 있습니다.

OS::TripleO::Services::CinderBackup: OS::Heat::None

이 서비스를 활성화하려면 puppet/services 디렉터리에 있는 해당 Heat 템플릿에 리소스를 연결하는 환경 파일을 포함합니다. 일부 서비스에는 환경 디렉터리에 사전 정의된 환경 파일이 있습니다. 예를 들어 Block Storage 백업 서비스는 다음을 포함하는 environments/cinder-backup.yaml 파일을 사용합니다.

resource_registry: OS::TripleO::Services::CinderBackup: ../puppet/services/pacemaker/cinder-backup.yaml ...

이렇게 하면 기본 null 작업 리소스를 재정의하고 서비스를 활성화합니다. openstack overcloud deploy 명령을 실행할 때 이 환경 파일을 포함합니다.

$ openstack overcloud deploy --templates -e /usr/share/openstack-tripleo-heat-templates/environments/cinder-backup.yaml

비활성화된 서비스를 활성화하는 방법에 대한 또 다른 예는 OpenStack Data Processing 가이드의 설치 섹션을 참조하십시오. 이 섹션에서는 오버클라우드에서 OpenStack Data Processing 서비스(sahara)를 활성화하는 방법에 대한 지침을 설명합니다.

6.4. 역할에서 서비스 추가 및 제거

서비스를 추가하거나 제거하는 기본 방법은 노드 역할에 대한 기본 서비스 목록의 사본을 생성한 다음 서비스를 추가하거나 제거해야 합니다. 예를 들어 컨트롤러 노드에서 OpenStack Orchestration(heat)을 제거하는 것이 좋습니다. 이 경우 기본 roles_data.yaml 파일의 사용자 정의 사본을 생성합니다.

$ cp /usr/share/openstack-tripleo-heat-templates/roles_data.yaml ~/templates/roles_data-no_heat.yaml

roles_data 파일을 편집하고 컨트롤러의 ServicesDefault 매개변수에 대한 서비스 목록을 수정합니다. OpenStack Orchestration 서비스로 스크롤하여 삭제합니다.

- OS::TripleO::Services::GlanceApi

- OS::TripleO::Services::GlanceRegistry

- OS::TripleO::Services::HeatApi # Remove this service

- OS::TripleO::Services::HeatApiCfn # Remove this service

- OS::TripleO::Services::HeatApiCloudwatch # Remove this service

- OS::TripleO::Services::HeatEngine # Remove this service

- OS::TripleO::Services::MySQL

- OS::TripleO::Services::NeutronDhcpAgent

openstack overcloud deploy 명령을 실행할 때 이 새로운 roles_data 파일을 포함합니다. 예를 들면 다음과 같습니다.

$ openstack overcloud deploy --templates -r ~/templates/roles_data-no_heat.yaml

그러면 컨트롤러 노드에 OpenStack Orchestration 서비스가 설치되지 않은 Overcloud가 배포됩니다.

사용자 지정 환경 파일을 사용하여 roles_data 파일에서 서비스를 비활성화할 수도 있습니다. 서비스를 리디렉션하여 비활성화를 OS::Heat::None 리소스로 리디렉션합니다. 예를 들면 다음과 같습니다.

resource_registry: OS::TripleO::Services::HeatApi: OS::Heat::None OS::TripleO::Services::HeatApiCfn: OS::Heat::None OS::TripleO::Services::HeatApiCloudwatch: OS::Heat::None OS::TripleO::Services::HeatEngine: OS::Heat::None

6.5. 새 역할 생성

이 예제에서 목표는 OpenStack Networking(중성자) 에이전트를 호스팅하는 새 Networker 역할을 생성하는 것입니다. 이 경우 새 역할 정보가 포함된 사용자 지정 roles_data 파일을 생성합니다.

기본 roles_data.yaml 파일의 사용자 정의 사본을 생성합니다.

$ cp /usr/share/openstack-tripleo-heat-templates/roles_data.yaml ~/templates/roles_data-network_node.yaml

새 roles_data 파일을 편집하고 기본 및 핵심 OpenStack Networking 서비스가 포함된 새 Networker 역할을 만듭니다. 예를 들면 다음과 같습니다.

- name: Networker

CountDefault: 1

HostnameFormatDefault: '%stackname%-networker-%index%'

ServicesDefault:

- OS::TripleO::Services::CACerts

- OS::TripleO::Services::FluentdClient

- OS::TripleO::Services::Kernel

- OS::TripleO::Services::NeutronDhcpAgent

- OS::TripleO::Services::NeutronL3Agent

- OS::TripleO::Services::NeutronMetadataAgent

- OS::TripleO::Services::NeutronOvsAgent

- OS::TripleO::Services::Ntp

- OS::TripleO::Services::SensuClient

- OS::TripleO::Services::Snmp

- OS::TripleO::Services::Timezone

- OS::TripleO::Services::TripleoPackages

- OS::TripleO::Services::TripleoFirewall

- OS::TripleO::Services::VipHosts

기본 Overcloud에 항상 Networking 노드가 포함되도록 CountDefault 를 1 로 설정하는 것도 좋습니다.

기존 오버클라우드에서 서비스를 스케일링하는 경우 기존 서비스를 Controller 역할에 유지합니다. 새 오버클라우드를 생성하고 OpenStack Networking 에이전트가 독립 실행형 역할만 유지하려면 Controller 역할 정의에서 OpenStack Networking 에이전트를 삭제합니다.

- name: Controller

CountDefault: 1

ServicesDefault:

- OS::TripleO::Services::CACerts

- OS::TripleO::Services::CephMon

- OS::TripleO::Services::CephExternal

- OS::TripleO::Services::CephRgw

- OS::TripleO::Services::CinderApi

- OS::TripleO::Services::CinderBackup

- OS::TripleO::Services::CinderScheduler

- OS::TripleO::Services::CinderVolume

- OS::TripleO::Services::Core

- OS::TripleO::Services::Kernel

- OS::TripleO::Services::Keystone

- OS::TripleO::Services::GlanceApi

- OS::TripleO::Services::GlanceRegistry

- OS::TripleO::Services::HeatApi

- OS::TripleO::Services::HeatApiCfn

- OS::TripleO::Services::HeatApiCloudwatch

- OS::TripleO::Services::HeatEngine

- OS::TripleO::Services::MySQL

- OS::TripleO::Services::NeutronDhcpAgent # Remove this service

- OS::TripleO::Services::NeutronL3Agent # Remove this service

- OS::TripleO::Services::NeutronMetadataAgent # Remove this service

- OS::TripleO::Services::NeutronApi

- OS::TripleO::Services::NeutronCorePlugin

- OS::TripleO::Services::NeutronOvsAgent # Remove this service

- OS::TripleO::Services::RabbitMQ

...

특정 노드에 태그를 지정할 수 있도록 이 역할에 새 플레이버를 정의해야 할 수 있습니다. 이 예제에서는 다음 명령을 사용하여 네트워크 플레이버를 생성합니다.

$ openstack flavor create --id auto --ram 6144 --disk 40 --vcpus 4 networker $ openstack flavor set --property "cpu_arch"="x86_64" --property "capabilities:boot_option"="local" --property "capabilities:profile"="networker" networker

다음 명령을 사용하여 새 플레이버에 노드를 태그합니다.

$ openstack baremetal node set --property capabilities='profile:networker,boot_option:local' 58c3d07e-24f2-48a7-bbb6-6843f0e8ee13

다음 환경 파일 스니펫을 사용하여 Networker 노드 수 및 플레이버를 정의합니다.

parameter_defaults: OvercloudNetworkerFlavor: networker NetworkerCount: 1

openstack overcloud deploy 명령을 실행할 때 새 roles_data 파일 및 환경 파일을 포함합니다. 예를 들면 다음과 같습니다.

$ openstack overcloud deploy --templates -r ~/templates/roles_data-network_node.yaml -e ~/templates/node-count-flavor.yaml

배포가 완료되면 컨트롤러 노드 1개, 컴퓨팅 노드 1개, Networker 노드로 구성된 3-노드 Overcloud가 생성됩니다. Overcloud의 노드 목록을 보려면 다음 명령을 실행합니다.

$ nova list

6.6. 서비스 없음으로 일반 노드 생성

Red Hat OpenStack Platform은 OpenStack 서비스를 구성하지 않고 일반 Red Hat Enterprise Linux 7 노드를 생성할 수 있는 기능을 제공합니다. 이는 핵심 Red Hat OpenStack Platform 환경 외부에서 소프트웨어를 호스팅해야 하는 경우에 유용합니다. 예를 들어 OpenStack Platform은 Kibana 및 Sensu와 같은 모니터링 툴과 통합을 제공합니다( 12장. 모니터링 도구 설정참조). Red Hat은 모니터링 툴 자체를 지원하지 않지만 director는 이러한 툴을 호스팅하는 일반 Red Hat Enterprise Linux 7 노드를 생성할 수 있습니다.

일반 노드는 여전히 기본 Red Hat Enterprise Linux 7 이미지가 아닌 기본 overcloud-full 이미지를 사용합니다. 즉, 노드에 일부 Red Hat OpenStack Platform 소프트웨어가 설치되어 있지만 활성화되거나 구성되지 않았습니다.

일반 노드를 생성하려면 ServicesDefault 목록이 없는 새 역할이 필요합니다.

- name: Generic

사용자 지정 roles_data 파일(roles_data_with_generic.yaml)에 역할을 포함합니다. 기존 컨트롤러 및 컴퓨팅 역할을 유지합니다.

환경 파일(Generic-node-params.yaml)을 포함하여 필요한 일반 Red Hat Enterprise Linux 7 노드 수와 프로비저닝할 노드를 선택할 때 플레이버를 지정할 수도 있습니다. 예를 들면 다음과 같습니다.

parameter_defaults: OvercloudGenericFlavor: baremetal GenericCount: 1

openstack overcloud deploy 명령을 실행할 때 역할 파일과 환경 파일을 모두 포함합니다. 예를 들면 다음과 같습니다.

$ openstack overcloud deploy --templates -r ~/templates/roles_data_with_generic.yaml -e ~/templates/generic-node-params.yaml

그러면 컨트롤러 노드 1개, 컴퓨팅 노드 1개, 일반적인 Red Hat Enterprise Linux 7 노드가 각각 하나씩 있는 3-노드 환경이 배포됩니다.

6.7. Hyper-Converged Compute 및 Ceph 서비스 생성

Hyper-Converged Compute 및 Ceph Services는 기술 프리뷰 기능입니다. 기술 프리뷰 기능은 Red Hat 서브스크립션 서비스 수준 계약(SLA)에서 완전히 지원되지 않으며 기능적으로 완전하지 않을 수 있으며 프로덕션용이 아닙니다. 그러나 이러한 기능을 통해 향후 제품 혁신에 조기에 액세스할 수 있어 고객이 개발 과정에서 기능을 테스트하고 피드백을 제공할 수 있습니다. 기술 프리뷰로 표시된 기능의 지원 범위에 대한 자세한 내용은 https://access.redhat.com/support/offerings/techpreview/ 을 참조하십시오.

Ceph OSD 서비스는 일반적으로 자체 Ceph Storage 노드에서 실행됩니다. 그러나 구성 가능 서비스는 대신 컴퓨팅 노드에서 Ceph OSD 서비스를 구성하는 방법을 제공합니다.

예를 들어 각 역할의 기본 서비스 목록에는 다음이 포함됩니다.

컴퓨팅 노드:

- name: Compute

CountDefault: 1

HostnameFormatDefault: '%stackname%-novacompute-%index%'

ServicesDefault:

- OS::TripleO::Services::CACerts

- OS::TripleO::Services::CephClient

- OS::TripleO::Services::CephExternal

- OS::TripleO::Services::Timezone

- OS::TripleO::Services::Ntp

- OS::TripleO::Services::Snmp

- OS::TripleO::Services::NovaCompute

- OS::TripleO::Services::NovaLibvirt

- OS::TripleO::Services::Kernel

- OS::TripleO::Services::ComputeNeutronCorePlugin

- OS::TripleO::Services::ComputeNeutronOvsAgent

- OS::TripleO::Services::ComputeCeilometerAgent

- OS::TripleO::Services::ComputeNeutronL3Agent

- OS::TripleO::Services::ComputeNeutronMetadataAgent

- OS::TripleO::Services::TripleoPackages

- OS::TripleO::Services::TripleoFirewall

- OS::TripleO::Services::NeutronSriovAgent

- OS::TripleO::Services::OpenDaylightOvs

- OS::TripleO::Services::SensuClient

- OS::TripleO::Services::FluentdClient

- OS::TripleO::Services::VipHosts

Ceph Storage 노드:

- name: CephStorage

ServicesDefault:

- OS::TripleO::Services::CACerts

- OS::TripleO::Services::CephOSD

- OS::TripleO::Services::Kernel

- OS::TripleO::Services::Ntp

- OS::TripleO::Services::Timezone

- OS::TripleO::Services::TripleoPackages

- OS::TripleO::Services::TripleoFirewall

- OS::TripleO::Services::SensuClient

- OS::TripleO::Services::FluentdClient

- OS::TripleO::Services::VipHosts

Ceph Storage 역할에는 Compute 역할에 공통된 서비스가 포함되어 있으므로 이를 무시할 수 있습니다. 하나의 서비스는 OS::TripleO::Services::CephOSD.

기본 roles_data 파일의 사용자 지정 버전을 생성합니다.

$ cp /usr/share/openstack-tripleo-heat-templates/roles_data.yaml ~/templates/roles_data-ceph_osd_on_compute.yaml

파일을 편집하여 OS::TripleO::Services::CephOSD 를 Compute 서비스 목록에 추가합니다.

- name: Compute

CountDefault: 1

HostnameFormatDefault: '%stackname%-novacompute-%index%'

ServicesDefault:

- OS::TripleO::Services::CACerts

- OS::TripleO::Services::CephClient

- OS::TripleO::Services::CephOSD

- OS::TripleO::Services::Timezone

- OS::TripleO::Services::Ntp

- OS::TripleO::Services::Snmp

- OS::TripleO::Services::NovaCompute

- OS::TripleO::Services::NovaLibvirt

- OS::TripleO::Services::Kernel

- OS::TripleO::Services::ComputeNeutronCorePlugin

- OS::TripleO::Services::ComputeNeutronOvsAgent

- OS::TripleO::Services::ComputeCeilometerAgent

- OS::TripleO::Services::ComputeNeutronL3Agent

- OS::TripleO::Services::ComputeNeutronMetadataAgent

- OS::TripleO::Services::TripleoPackages

- OS::TripleO::Services::TripleoFirewall

- OS::TripleO::Services::NeutronSriovAgent

- OS::TripleO::Services::OpenDaylightOvs

- OS::TripleO::Services::SensuClient

- OS::TripleO::Services::FluentdClient

- OS::TripleO::Services::VipHosts

Overcloud가 외부 Ceph Storage 클러스터와 통합되지 않기 때문에 Compute 서비스 목록에서 OS::TripleO::Services::CephExternal 서비스를 안전하게 제거할 수도 있습니다.

openstack overcloud deploy 명령을 실행할 때 이 역할 파일을 포함합니다. 예를 들면 다음과 같습니다.

$ openstack overcloud deploy --templates -r ~/templates/roles_data-ceph_osd_on_compute.yaml -e ~/template/storage-environment.yaml

이 명령에는 Ceph Storage 관련 매개변수가 포함된 스토리지(storage-environment.yaml)용 사용자 지정 환경 파일도 포함되어 있습니다.

Overcloud 배포 후 컴퓨팅 노드에 Ceph OSD 설치를 확인합니다. 컴퓨팅 노드에 로그인하고 다음을 실행합니다.

[root@overcloud-novacompute-0 ~]# ps ax | grep ceph 17437 ? Ss 0:00 /bin/bash -c ulimit -n 32768; /usr/bin/ceph-osd -i 0 --pid-file /var/run/ceph/osd.0.pid -c /etc/ceph/ceph.conf --cluster ceph -f 17438 ? Sl 0:00 /usr/bin/ceph-osd -i 0 --pid-file /var/run/ceph/osd.0.pid -c /etc/ceph/ceph.conf --cluster ceph -f

6.8. 서비스 아키텍처:ECDHElithic Controller

구성 가능 서비스의 기본 아키텍처에서는 코어 Red Hat OpenStack Platform Services를 포함하는 모놀리식 컨트롤러를 사용합니다. 이러한 기본 서비스는 director의 Heat 템플릿 컬렉션(/usr/share/openstack-tripleo-heat-templates/roles_data.yaml)에 포함된 역할 파일에 정의되어 있습니다.

일부 서비스는 기본적으로 비활성화되어 있습니다. 이러한 서비스 활성화 방법에 대한 자세한 내용은 6.3절. “Disabled 서비스 활성화” 를 참조하십시오.

- name: Controller

ServicesDefault:

- OS::TripleO::Services::Apache

- OS::TripleO::Services::AodhApi

- OS::TripleO::Services::AodhEvaluator

- OS::TripleO::Services::AodhListener

- OS::TripleO::Services::AodhNotifier

- OS::TripleO::Services::CACerts

- OS::TripleO::Services::CeilometerAgentCentral

- OS::TripleO::Services::CeilometerAgentNotification

- OS::TripleO::Services::CeilometerApi

- OS::TripleO::Services::CeilometerCollector

- OS::TripleO::Services::CeilometerExpirer

- OS::TripleO::Services::CephClient

- OS::TripleO::Services::CephExternal

- OS::TripleO::Services::CephMon

- OS::TripleO::Services::CephRgw

- OS::TripleO::Services::CinderApi

- OS::TripleO::Services::CinderBackup

- OS::TripleO::Services::CinderScheduler

- OS::TripleO::Services::CinderVolume

- OS::TripleO::Services::FluentdClient

- OS::TripleO::Services::GlanceApi

- OS::TripleO::Services::GlanceRegistry

- OS::TripleO::Services::GnocchiApi

- OS::TripleO::Services::GnocchiMetricd

- OS::TripleO::Services::GnocchiStatsd

- OS::TripleO::Services::HAproxy

- OS::TripleO::Services::HeatApi

- OS::TripleO::Services::HeatApiCfn

- OS::TripleO::Services::HeatApiCloudwatch

- OS::TripleO::Services::HeatEngine

- OS::TripleO::Services::Horizon

- OS::TripleO::Services::IronicApi

- OS::TripleO::Services::IronicConductor

- OS::TripleO::Services::Kernel

- OS::TripleO::Services::Keepalived

- OS::TripleO::Services::Keystone

- OS::TripleO::Services::ManilaApi

- OS::TripleO::Services::ManilaBackendCephFs

- OS::TripleO::Services::ManilaBackendGeneric

- OS::TripleO::Services::ManilaBackendNetapp

- OS::TripleO::Services::ManilaScheduler

- OS::TripleO::Services::ManilaShare

- OS::TripleO::Services::Memcached

- OS::TripleO::Services::MongoDb

- OS::TripleO::Services::MySQL

- OS::TripleO::Services::NeutronApi

- OS::TripleO::Services::NeutronCorePlugin

- OS::TripleO::Services::NeutronCorePluginML2OVN

- OS::TripleO::Services::NeutronCorePluginMidonet

- OS::TripleO::Services::NeutronCorePluginNuage

- OS::TripleO::Services::NeutronCorePluginOpencontrail

- OS::TripleO::Services::NeutronCorePluginPlumgrid

- OS::TripleO::Services::NeutronDhcpAgent

- OS::TripleO::Services::NeutronL3Agent

- OS::TripleO::Services::NeutronMetadataAgent

- OS::TripleO::Services::NeutronOvsAgent

- OS::TripleO::Services::NovaApi

- OS::TripleO::Services::NovaConductor

- OS::TripleO::Services::NovaConsoleauth

- OS::TripleO::Services::NovaIronic

- OS::TripleO::Services::NovaScheduler

- OS::TripleO::Services::NovaVncProxy

- OS::TripleO::Services::Ntp

- OS::TripleO::Services::OpenDaylightApi

- OS::TripleO::Services::OpenDaylightOvs

- OS::TripleO::Services::Pacemaker

- OS::TripleO::Services::RabbitMQ

- OS::TripleO::Services::Redis

- OS::TripleO::Services::SaharaApi

- OS::TripleO::Services::SaharaEngine

- OS::TripleO::Services::SensuClient

- OS::TripleO::Services::Sshd

- OS::TripleO::Services::Snmp

- OS::TripleO::Services::SwiftProxy

- OS::TripleO::Services::SwiftRingBuilder

- OS::TripleO::Services::Timezone

- OS::TripleO::Services::TripleoFirewall

- OS::TripleO::Services::TripleoPackages

- OS::TripleO::Services::VipHosts6.9. 서비스 아키텍처: 분할 컨트롤러

컨트롤러 노드의 서비스를 두 개의 별도의 역할로 분할할 수 있습니다.

- 컨트롤러 PCMK - 데이터베이스 및 로드 밸런싱을 포함하여 Pacemaker에서 관리하는 핵심 서비스만 포함합니다.

- 컨트롤러 systemd - 모든 OpenStack 서비스 포함

나머지 기본 역할(Compute, Ceph Storage, Object Storage, Block Storage)은 영향을 받지 않습니다.

다음 표는 분할 컨트롤러 아키텍처를 생성하는 가이드로 사용합니다.

일부 서비스는 기본적으로 비활성화되어 있습니다. 이러한 서비스 활성화 방법에 대한 자세한 내용은 6.3절. “Disabled 서비스 활성화” 를 참조하십시오.

컨트롤러 PCMK

다음 서비스는 컨트롤러 PCMK 역할에 필요한 최소 서비스입니다.

- name: Controller

ServicesDefault:

- OS::TripleO::Services::CACerts

- OS::TripleO::Services::FluentdClient

- OS::TripleO::Services::Kernel

- OS::TripleO::Services::Ntp

- OS::TripleO::Services::SensuClient

- OS::TripleO::Services::Sshd

- OS::TripleO::Services::Snmp

- OS::TripleO::Services::Timezone

- OS::TripleO::Services::TripleoFirewall

- OS::TripleO::Services::TripleoPackages

- OS::TripleO::Services::VipHosts

- OS::TripleO::Services::CephClient

- OS::TripleO::Services::CephExternal

- OS::TripleO::Services::CinderBackup

- OS::TripleO::Services::CinderVolume

- OS::TripleO::Services::HAproxy

- OS::TripleO::Services::Keepalived

- OS::TripleO::Services::ManilaBackendGeneric

- OS::TripleO::Services::ManilaBackendNetapp

- OS::TripleO::Services::ManilaBackendCephFs

- OS::TripleO::Services::ManilaShare

- OS::TripleO::Services::Memcached

- OS::TripleO::Services::MySQL

- OS::TripleO::Services::Pacemaker

- OS::TripleO::Services::RabbitMQ

- OS::TripleO::Services::Redis컨트롤러 systemd

다음 표는 컨트롤러 systemd 역할에서 사용할 수 있는 서비스를 나타냅니다.

- name: ControllerSystemd

ServicesDefault:

- OS::TripleO::Services::Apache

- OS::TripleO::Services::AodhApi

- OS::TripleO::Services::AodhEvaluator

- OS::TripleO::Services::AodhListener

- OS::TripleO::Services::AodhNotifier

- OS::TripleO::Services::CACerts

- OS::TripleO::Services::CeilometerAgentCentral

- OS::TripleO::Services::CeilometerAgentNotification

- OS::TripleO::Services::CeilometerApi

- OS::TripleO::Services::CeilometerCollector

- OS::TripleO::Services::CeilometerExpirer

- OS::TripleO::Services::CephClient

- OS::TripleO::Services::CephExternal

- OS::TripleO::Services::CephMon

- OS::TripleO::Services::CephRgw

- OS::TripleO::Services::CinderApi

- OS::TripleO::Services::CinderScheduler

- OS::TripleO::Services::FluentdClient

- OS::TripleO::Services::GlanceApi

- OS::TripleO::Services::GlanceRegistry

- OS::TripleO::Services::GnocchiApi

- OS::TripleO::Services::GnocchiMetricd

- OS::TripleO::Services::GnocchiStatsd

- OS::TripleO::Services::HeatApi

- OS::TripleO::Services::HeatApiCfn

- OS::TripleO::Services::HeatApiCloudwatch

- OS::TripleO::Services::HeatEngine

- OS::TripleO::Services::Horizon

- OS::TripleO::Services::IronicApi

- OS::TripleO::Services::IronicConductor

- OS::TripleO::Services::Kernel

- OS::TripleO::Services::Keystone

- OS::TripleO::Services::ManilaApi

- OS::TripleO::Services::ManilaScheduler

- OS::TripleO::Services::MongoDb

- OS::TripleO::Services::NeutronApi

- OS::TripleO::Services::NeutronCorePlugin

- OS::TripleO::Services::NeutronCorePluginML2OVN

- OS::TripleO::Services::NeutronCorePluginMidonet

- OS::TripleO::Services::NeutronCorePluginNuage

- OS::TripleO::Services::NeutronCorePluginOpencontrail

- OS::TripleO::Services::NeutronCorePluginPlumgrid

- OS::TripleO::Services::NeutronDhcpAgent

- OS::TripleO::Services::NeutronL3Agent

- OS::TripleO::Services::NeutronMetadataAgent

- OS::TripleO::Services::NeutronOvsAgent

- OS::TripleO::Services::NovaApi

- OS::TripleO::Services::NovaConductor

- OS::TripleO::Services::NovaConsoleauth

- OS::TripleO::Services::NovaIronic

- OS::TripleO::Services::NovaScheduler

- OS::TripleO::Services::NovaVncProxy

- OS::TripleO::Services::Ntp

- OS::TripleO::Services::OpenDaylightApi

- OS::TripleO::Services::OpenDaylightOvs

- OS::TripleO::Services::SaharaApi

- OS::TripleO::Services::SaharaEngine

- OS::TripleO::Services::SensuClient

- OS::TripleO::Services::Sshd

- OS::TripleO::Services::Snmp

- OS::TripleO::Services::SwiftProxy

- OS::TripleO::Services::SwiftRingBuilder

- OS::TripleO::Services::Timezone

- OS::TripleO::Services::TripleoFirewall

- OS::TripleO::Services::TripleoPackages

- OS::TripleO::Services::VipHosts6.10. 서비스 아키텍처: 독립 실행형 역할

다음 표에는 Red Hat OpenStack Platform에서 구성 가능 서비스 아키텍처를 사용하여 생성하고 확장할 수 있는 사용자 정의 역할 컬렉션이 나열되어 있습니다. 이러한 컬렉션을 개별 역할로 그룹화하고 이를 사용하여 이전 아키텍처와 함께 서비스를 분리하고 분할합니다.

일부 서비스는 기본적으로 비활성화되어 있습니다. 이러한 서비스 활성화 방법에 대한 자세한 내용은 6.3절. “Disabled 서비스 활성화” 를 참조하십시오.

모든 역할은 다음과 같은 공통 서비스 세트를 사용합니다.

-

OS::TripleO::Services::CACerts -

OS::TripleO::Services::FluentdClient -

OS::TripleO::Services::Kernel -

OS::TripleO::Services::Ntp -

OS::TripleO::Services::SensuClient -

OS::TripleO::Services::Sshd -

OS::TripleO::Services::Snmp -

OS::TripleO::Services::Timezone -

OS::TripleO::Services::TripleoFirewall -

OS::TripleO::Services::TripleoPackages -

OS::TripleO::Services::VipHosts

오버클라우드에 포함할 역할을 선택한 후 기본 컨트롤러 역할에서 관련 서비스( 일반 서비스제외)를 삭제합니다. 예를 들어 독립 실행형 Keystone 역할을 생성하는 경우 컨트롤러 노드에서 OS::TripleO::Services::Apache 및 OS::TripleO::Services::Keystone 서비스를 제거합니다. 유일한 예외는 사용자 정의 역할 지원이 제한된 서비스입니다( 표 6.1. “사용자 정의 역할 지원”참조).

다음 표에서 역할을 클릭하여 연결된 서비스를 확인합니다.

표 6.1. 사용자 정의 역할 지원

| Role | 지원 상태 |

|---|---|

| 지원됨 | |

| 지원됨 | |

| 제한됨. 분할하는 경우 이 서비스는 컨트롤러 systemd 역할의 일부여야 합니다. | |

| 지원됨 | |

| 지원됨 | |

| 지원됨 | |

| 지원됨 | |

| 지원됨 | |

| 제한됨. 분할하는 경우 이 서비스는 컨트롤러 systemd 역할의 일부여야 합니다. | |

| 지원됨 | |

| 제한됨. 분할하는 경우 이 서비스는 컨트롤러 systemd 역할의 일부여야 합니다. | |

| 지원됨 | |

| 지원됨 | |

| 지원됨 | |

| 지원됨 | |

| 기술 프리뷰 | |

| 제한됨. 분할하는 경우 이 서비스는 컨트롤러 systemd 역할의 일부여야 합니다. | |

| 지원됨 | |

| 지원됨 | |

| 지원됨 |

Ceph Storage 모니터

다음 서비스는 Ceph Storage 모니터를 구성합니다.

- name: CephMon

ServicesDefault:

- OS::TripleO::Services::CACerts

- OS::TripleO::Services::FluentdClient

- OS::TripleO::Services::Kernel

- OS::TripleO::Services::Ntp

- OS::TripleO::Services::SensuClient

- OS::TripleO::Services::Sshd

- OS::TripleO::Services::Snmp

- OS::TripleO::Services::Timezone

- OS::TripleO::Services::TripleoFirewall

- OS::TripleO::Services::TripleoPackages

- OS::TripleO::Services::VipHosts

- OS::TripleO::Services::CephMonCeph Storage OSD

다음 서비스는 Ceph Storage OSD를 구성합니다.

- name: CephStorage

ServicesDefault:

- OS::TripleO::Services::CACerts

- OS::TripleO::Services::FluentdClient

- OS::TripleO::Services::Kernel

- OS::TripleO::Services::Ntp

- OS::TripleO::Services::SensuClient

- OS::TripleO::Services::Sshd

- OS::TripleO::Services::Snmp

- OS::TripleO::Services::Timezone

- OS::TripleO::Services::TripleoFirewall

- OS::TripleO::Services::TripleoPackages

- OS::TripleO::Services::VipHosts

- OS::TripleO::Services::CephOSDCeph Storage RadosGW

다음 서비스는 Ceph Storage RadosGW를 구성합니다. 이러한 서비스를 분리하는 경우 컨트롤러 systemd 역할에 포함되어야 합니다.

- OS::TripleO::Services::CACerts

- OS::TripleO::Services::FluentdClient

- OS::TripleO::Services::Kernel

- OS::TripleO::Services::Ntp

- OS::TripleO::Services::SensuClient

- OS::TripleO::Services::Sshd

- OS::TripleO::Services::Snmp

- OS::TripleO::Services::Timezone

- OS::TripleO::Services::TripleoFirewall

- OS::TripleO::Services::TripleoPackages

- OS::TripleO::Services::VipHosts

- OS::TripleO::Services::CephRgw

- OS::TripleO::Services::CephClientCinder API

다음 서비스는 OpenStack Block Storage API를 구성합니다.

- name: CinderApi

ServicesDefault:

- OS::TripleO::Services::CACerts

- OS::TripleO::Services::FluentdClient

- OS::TripleO::Services::Kernel

- OS::TripleO::Services::Ntp

- OS::TripleO::Services::SensuClient

- OS::TripleO::Services::Sshd

- OS::TripleO::Services::Snmp

- OS::TripleO::Services::Timezone

- OS::TripleO::Services::TripleoFirewall

- OS::TripleO::Services::TripleoPackages

- OS::TripleO::Services::VipHosts

- OS::TripleO::Services::CinderApi

- OS::TripleO::Services::CinderScheduler컨트롤러 PCMK

다음 서비스는 컨트롤러 PCMK 역할에 필요한 최소 서비스입니다.

- name: ControllerPcmk

ServicesDefault:

- OS::TripleO::Services::CACerts

- OS::TripleO::Services::FluentdClient

- OS::TripleO::Services::Kernel

- OS::TripleO::Services::Ntp

- OS::TripleO::Services::SensuClient

- OS::TripleO::Services::Sshd

- OS::TripleO::Services::Snmp

- OS::TripleO::Services::Timezone

- OS::TripleO::Services::TripleoFirewall

- OS::TripleO::Services::TripleoPackages

- OS::TripleO::Services::CephClient

- OS::TripleO::Services::CephExternal

- OS::TripleO::Services::CinderBackup

- OS::TripleO::Services::CinderVolume

- OS::TripleO::Services::HAproxy

- OS::TripleO::Services::Keepalived

- OS::TripleO::Services::ManilaBackendGeneric

- OS::TripleO::Services::ManilaBackendNetapp

- OS::TripleO::Services::ManilaBackendCephFs

- OS::TripleO::Services::ManilaShare

- OS::TripleO::Services::Memcached

- OS::TripleO::Services::MySQL

- OS::TripleO::Services::Pacemaker

- OS::TripleO::Services::RabbitMQ

- OS::TripleO::Services::Redis

- OS::TripleO::Services::VipHostsGlance

다음 서비스는 OpenStack 이미지 서비스를 구성합니다.

- name: Glance

ServicesDefault:

- OS::TripleO::Services::CACerts

- OS::TripleO::Services::FluentdClient

- OS::TripleO::Services::Kernel

- OS::TripleO::Services::Ntp

- OS::TripleO::Services::SensuClient

- OS::TripleO::Services::Sshd

- OS::TripleO::Services::Snmp

- OS::TripleO::Services::Timezone

- OS::TripleO::Services::TripleoFirewall

- OS::TripleO::Services::TripleoPackages

- OS::TripleO::Services::VipHosts

- OS::TripleO::Services::CephClient

- OS::TripleO::Services::CephExternal

- OS::TripleO::Services::GlanceApi

- OS::TripleO::Services::GlanceRegistryHeat

다음 서비스는 OpenStack Orchestration 서비스를 구성합니다.

- name: Heat

ServicesDefault:

- OS::TripleO::Services::CACerts

- OS::TripleO::Services::FluentdClient

- OS::TripleO::Services::Kernel

- OS::TripleO::Services::Ntp

- OS::TripleO::Services::SensuClient

- OS::TripleO::Services::Sshd

- OS::TripleO::Services::Snmp

- OS::TripleO::Services::Timezone

- OS::TripleO::Services::TripleoFirewall

- OS::TripleO::Services::TripleoPackages

- OS::TripleO::Services::VipHosts

- OS::TripleO::Services::HeatApi

- OS::TripleO::Services::HeatApiCfn

- OS::TripleO::Services::HeatApiCloudwatch

- OS::TripleO::Services::HeatEngineHorizon

다음 서비스는 OpenStack 대시보드를 구성합니다.

- name: Horizon

ServicesDefault:

- OS::TripleO::Services::CACerts

- OS::TripleO::Services::FluentdClient

- OS::TripleO::Services::Kernel

- OS::TripleO::Services::Ntp

- OS::TripleO::Services::SensuClient

- OS::TripleO::Services::Sshd

- OS::TripleO::Services::Snmp

- OS::TripleO::Services::Timezone

- OS::TripleO::Services::TripleoFirewall

- OS::TripleO::Services::TripleoPackages

- OS::TripleO::Services::VipHosts

- OS::TripleO::Services::Apache

- OS::TripleO::Services::Horizonironic

다음 서비스는 OpenStack Bare Metal Provisioning 서비스를 구성합니다. 이러한 서비스를 분리하는 경우 컨트롤러 systemd 역할에 포함되어야 합니다.

- OS::TripleO::Services::CACerts

- OS::TripleO::Services::FluentdClient

- OS::TripleO::Services::Kernel

- OS::TripleO::Services::Ntp

- OS::TripleO::Services::SensuClient

- OS::TripleO::Services::Sshd

- OS::TripleO::Services::Snmp

- OS::TripleO::Services::Timezone

- OS::TripleO::Services::TripleoFirewall

- OS::TripleO::Services::TripleoPackages

- OS::TripleO::Services::VipHosts

- OS::TripleO::Services::IronicApi

- OS::TripleO::Services::IronicConductor

- OS::TripleO::Services::NovaIronicKeystone

다음 서비스는 OpenStack ID 서비스를 구성합니다. 마이너 업데이트를 수행할 때 다른 서비스를 업데이트하기 전에 이 역할을 업데이트해야 합니다.

- name: Keystone

ServicesDefault:

- OS::TripleO::Services::CACerts

- OS::TripleO::Services::FluentdClient

- OS::TripleO::Services::Kernel

- OS::TripleO::Services::Ntp

- OS::TripleO::Services::SensuClient

- OS::TripleO::Services::Sshd

- OS::TripleO::Services::Snmp

- OS::TripleO::Services::Timezone

- OS::TripleO::Services::TripleoFirewall

- OS::TripleO::Services::TripleoPackages

- OS::TripleO::Services::VipHosts

- OS::TripleO::Services::Apache

- OS::TripleO::Services::KeystoneManila

다음 서비스는 OpenStack Shared File Systems 서비스를 구성합니다. 이러한 서비스를 분리하는 경우 컨트롤러 systemd 역할에 포함되어야 합니다.

- OS::TripleO::Services::CACerts

- OS::TripleO::Services::FluentdClient

- OS::TripleO::Services::Kernel

- OS::TripleO::Services::Ntp

- OS::TripleO::Services::SensuClient

- OS::TripleO::Services::Sshd

- OS::TripleO::Services::Snmp

- OS::TripleO::Services::Timezone

- OS::TripleO::Services::TripleoFirewall

- OS::TripleO::Services::TripleoPackages

- OS::TripleO::Services::VipHosts

- OS::TripleO::Services::ManilaApi

- OS::TripleO::Services::ManilaSchedulerNetworker

다음 서비스는 OpenStack Networking 에이전트를 구성합니다.

- name: Networker

ServicesDefault:

- OS::TripleO::Services::CACerts

- OS::TripleO::Services::FluentdClient

- OS::TripleO::Services::Kernel

- OS::TripleO::Services::Ntp

- OS::TripleO::Services::SensuClient

- OS::TripleO::Services::Sshd

- OS::TripleO::Services::Snmp

- OS::TripleO::Services::Timezone

- OS::TripleO::Services::TripleoFirewall

- OS::TripleO::Services::TripleoPackages

- OS::TripleO::Services::VipHosts

- OS::TripleO::Services::NeutronDhcpAgent

- OS::TripleO::Services::NeutronL3Agent

- OS::TripleO::Services::NeutronMetadataAgent

- OS::TripleO::Services::NeutronOvsAgentNeutron API

다음 서비스는 OpenStack Networking API를 구성합니다.

- name: NeutronApi

ServicesDefault:

- OS::TripleO::Services::CACerts

- OS::TripleO::Services::FluentdClient

- OS::TripleO::Services::Kernel

- OS::TripleO::Services::Ntp

- OS::TripleO::Services::SensuClient

- OS::TripleO::Services::Sshd

- OS::TripleO::Services::Snmp

- OS::TripleO::Services::Timezone

- OS::TripleO::Services::TripleoFirewall

- OS::TripleO::Services::TripleoPackages

- OS::TripleO::Services::VipHosts

- OS::TripleO::Services::NeutronApi

- OS::TripleO::Services::NeutronCorePlugin

- OS::TripleO::Services::NeutronCorePluginML2OVN

- OS::TripleO::Services::NeutronCorePluginMidonet

- OS::TripleO::Services::NeutronCorePluginNuage

- OS::TripleO::Services::NeutronCorePluginOpencontrail

- OS::TripleO::Services::NeutronCorePluginPlumgridNova

다음 서비스는 OpenStack Compute 서비스를 구성합니다.

- name: Nova

ServicesDefault:

- OS::TripleO::Services::CACerts

- OS::TripleO::Services::FluentdClient

- OS::TripleO::Services::Kernel

- OS::TripleO::Services::Ntp

- OS::TripleO::Services::SensuClient

- OS::TripleO::Services::Sshd

- OS::TripleO::Services::Snmp

- OS::TripleO::Services::Timezone

- OS::TripleO::Services::TripleoFirewall

- OS::TripleO::Services::TripleoPackages

- OS::TripleO::Services::VipHosts

- OS::TripleO::Services::NovaApi

- OS::TripleO::Services::NovaConductor

- OS::TripleO::Services::NovaConsoleauth

- OS::TripleO::Services::NovaScheduler

- OS::TripleO::Services::NovaVncProxyNova Compute

다음 서비스는 OpenStack 컴퓨팅 노드를 구성합니다.

- name: Compute

ServicesDefault:

- OS::TripleO::Services::CACerts

- OS::TripleO::Services::FluentdClient

- OS::TripleO::Services::Kernel

- OS::TripleO::Services::Ntp

- OS::TripleO::Services::SensuClient

- OS::TripleO::Services::Sshd

- OS::TripleO::Services::Snmp

- OS::TripleO::Services::Timezone

- OS::TripleO::Services::TripleoFirewall

- OS::TripleO::Services::TripleoPackages

- OS::TripleO::Services::VipHosts

- OS::TripleO::Services::CephClient

- OS::TripleO::Services::CephExternal

- OS::TripleO::Services::ComputeCeilometerAgent

- OS::TripleO::Services::ComputeNeutronCorePlugin

- OS::TripleO::Services::ComputeNeutronL3Agent

- OS::TripleO::Services::ComputeNeutronMetadataAgent

- OS::TripleO::Services::ComputeNeutronOvsAgent

- OS::TripleO::Services::NeutronSriovAgent

- OS::TripleO::Services::NovaCompute

- OS::TripleO::Services::NovaLibvirt

- OS::TripleO::Services::OpenDaylightOvsOpenDaylight

다음 서비스에서 OpenDayLight를 구성합니다. 이러한 서비스는 Red Hat OpenStack Platform 10의 기술 프리뷰 입니다.

- name: Opendaylight

ServicesDefault:

- OS::TripleO::Services::CACerts

- OS::TripleO::Services::FluentdClient

- OS::TripleO::Services::Kernel

- OS::TripleO::Services::Ntp

- OS::TripleO::Services::SensuClient

- OS::TripleO::Services::Sshd

- OS::TripleO::Services::Snmp

- OS::TripleO::Services::Timezone

- OS::TripleO::Services::TripleoFirewall

- OS::TripleO::Services::TripleoPackages

- OS::TripleO::Services::VipHosts

- OS::TripleO::Services::OpenDaylightApi

- OS::TripleO::Services::OpenDaylightOvsSahara

다음 서비스는 OpenStackECDHE 서비스를 구성합니다. 이러한 서비스를 분리하는 경우 컨트롤러 systemd 역할의 일부가되어야합니다.

- OS::TripleO::Services::CACerts

- OS::TripleO::Services::FluentdClient

- OS::TripleO::Services::Kernel

- OS::TripleO::Services::Ntp

- OS::TripleO::Services::SensuClient

- OS::TripleO::Services::Sshd

- OS::TripleO::Services::Snmp

- OS::TripleO::Services::Timezone

- OS::TripleO::Services::TripleoFirewall

- OS::TripleO::Services::TripleoPackages

- OS::TripleO::Services::VipHosts

- OS::TripleO::Services::SaharaApi

- OS::TripleO::Services::SaharaEngineSwift API

다음 서비스는 OpenStack Object Storage API를 구성합니다.

- name: SwiftApi

ServicesDefault:

- OS::TripleO::Services::CACerts

- OS::TripleO::Services::FluentdClient

- OS::TripleO::Services::Kernel

- OS::TripleO::Services::Ntp

- OS::TripleO::Services::SensuClient

- OS::TripleO::Services::Sshd

- OS::TripleO::Services::Snmp

- OS::TripleO::Services::Timezone

- OS::TripleO::Services::TripleoFirewall

- OS::TripleO::Services::TripleoPackages

- OS::TripleO::Services::VipHosts

- OS::TripleO::Services::SwiftProxy

- OS::TripleO::Services::SwiftRingBuilderSwift Storage

다음 서비스는 OpenStack Object Storage 서비스를 구성합니다.

- name: ObjectStorage

ServicesDefault:

- OS::TripleO::Services::CACerts

- OS::TripleO::Services::FluentdClient

- OS::TripleO::Services::Kernel

- OS::TripleO::Services::Ntp

- OS::TripleO::Services::SensuClient

- OS::TripleO::Services::Sshd

- OS::TripleO::Services::Snmp

- OS::TripleO::Services::Timezone

- OS::TripleO::Services::TripleoFirewall

- OS::TripleO::Services::TripleoPackages

- OS::TripleO::Services::VipHosts

- OS::TripleO::Services::SwiftRingBuilder

- OS::TripleO::Services::SwiftStoragetelemetry

다음 서비스는 OpenStack Telemetry 서비스를 구성합니다.

- name: Telemetry

ServicesDefault:

- OS::TripleO::Services::CACerts

- OS::TripleO::Services::FluentdClient

- OS::TripleO::Services::Kernel

- OS::TripleO::Services::Ntp

- OS::TripleO::Services::SensuClient

- OS::TripleO::Services::Sshd

- OS::TripleO::Services::Snmp

- OS::TripleO::Services::Timezone

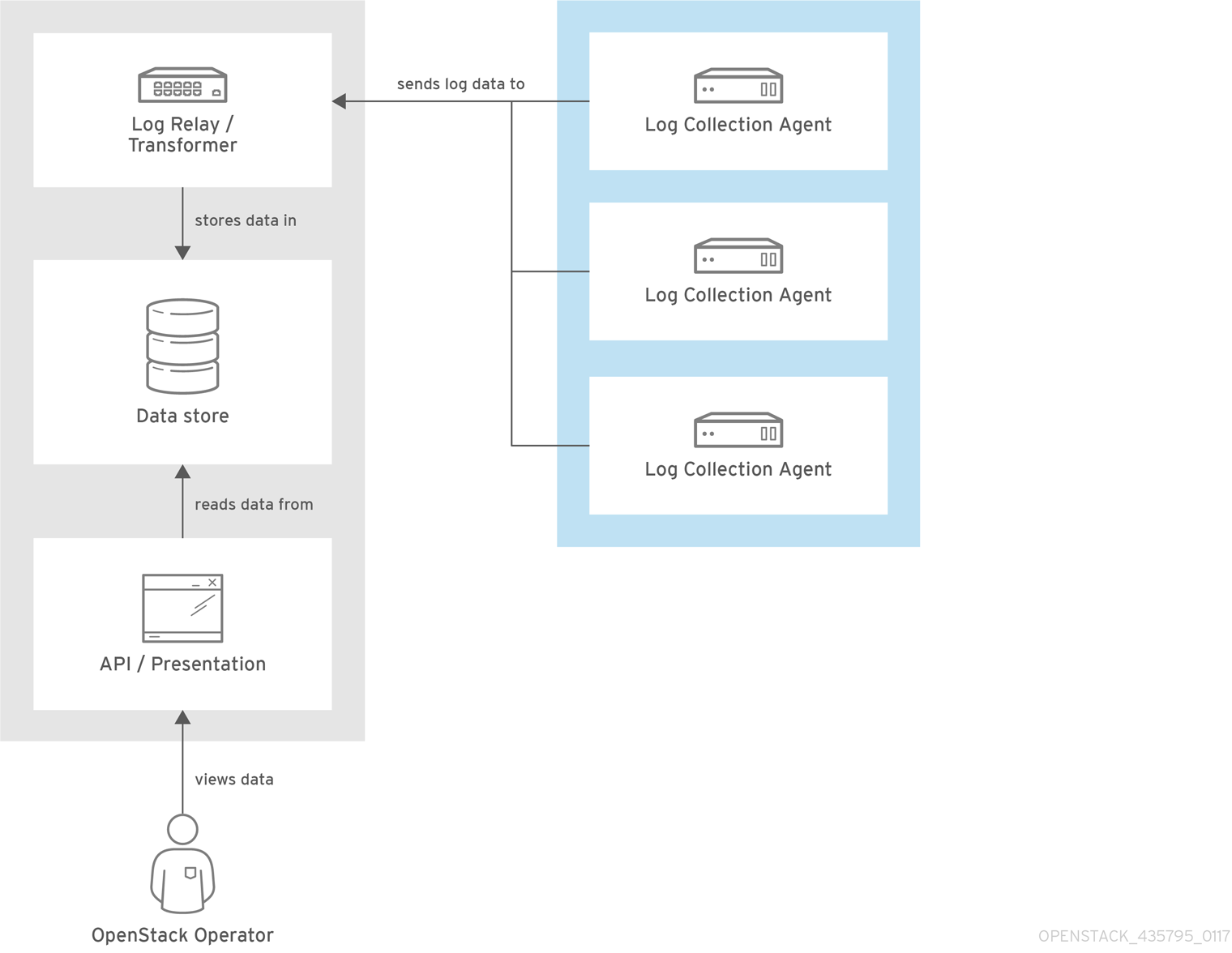

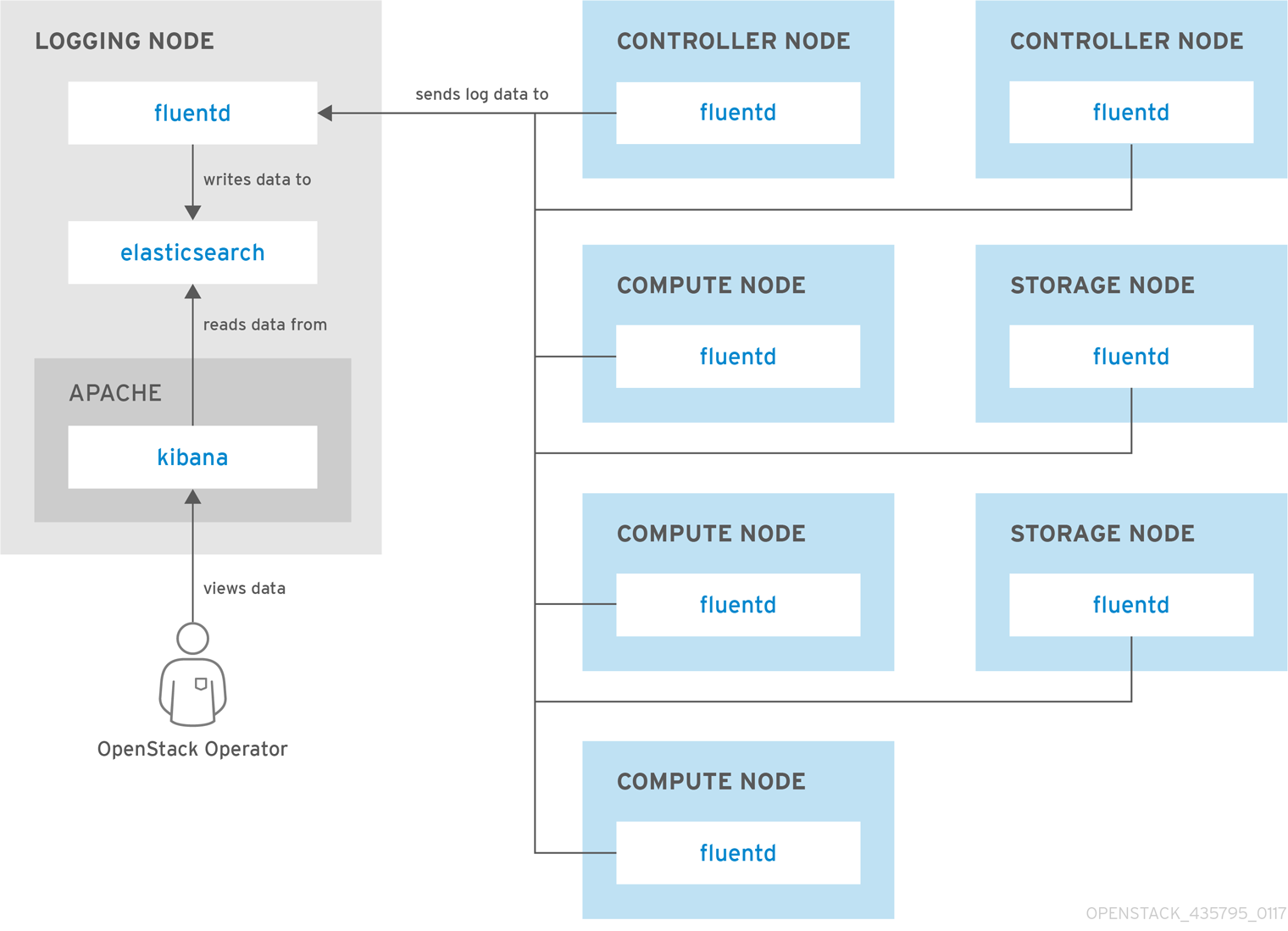

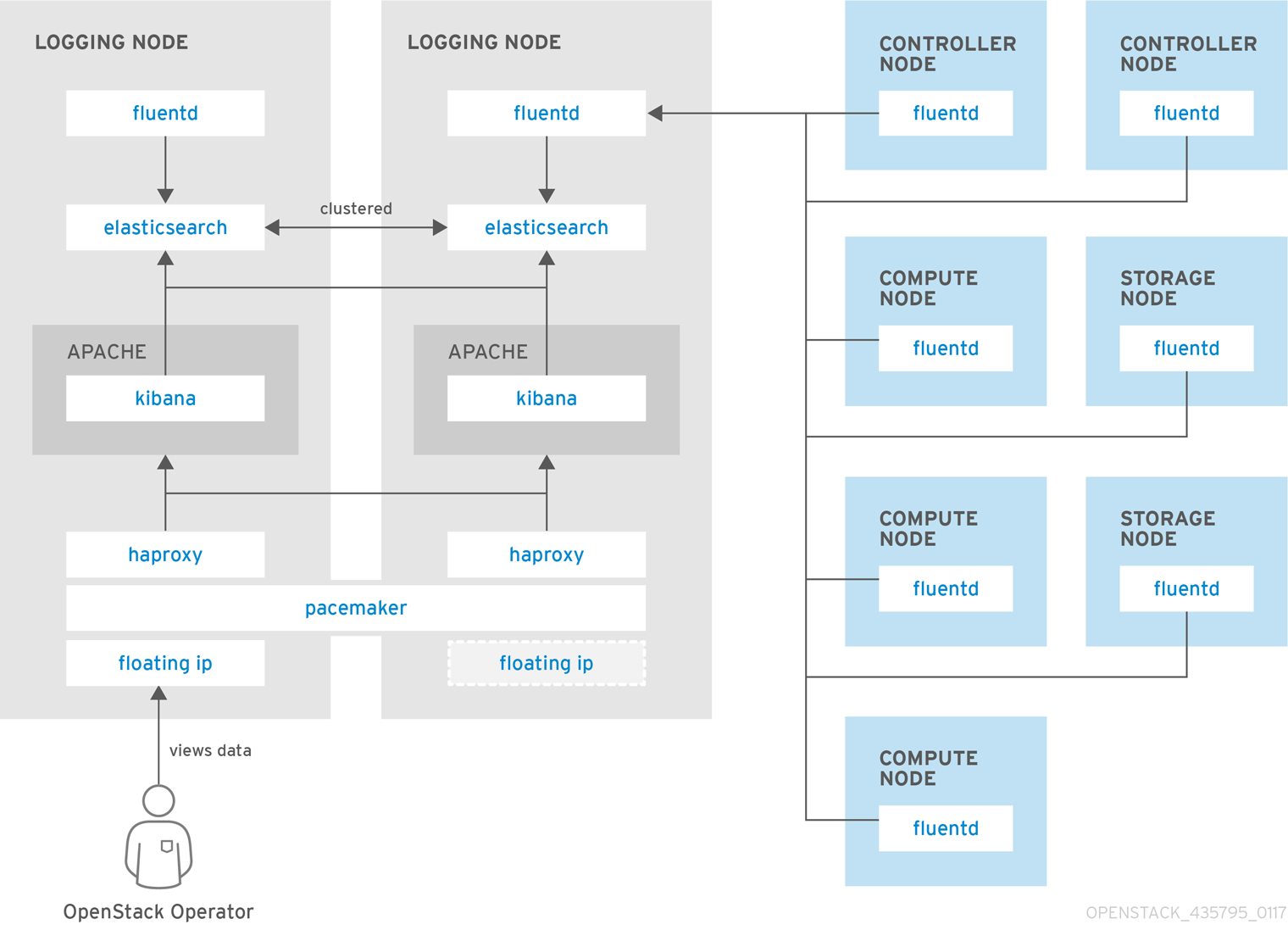

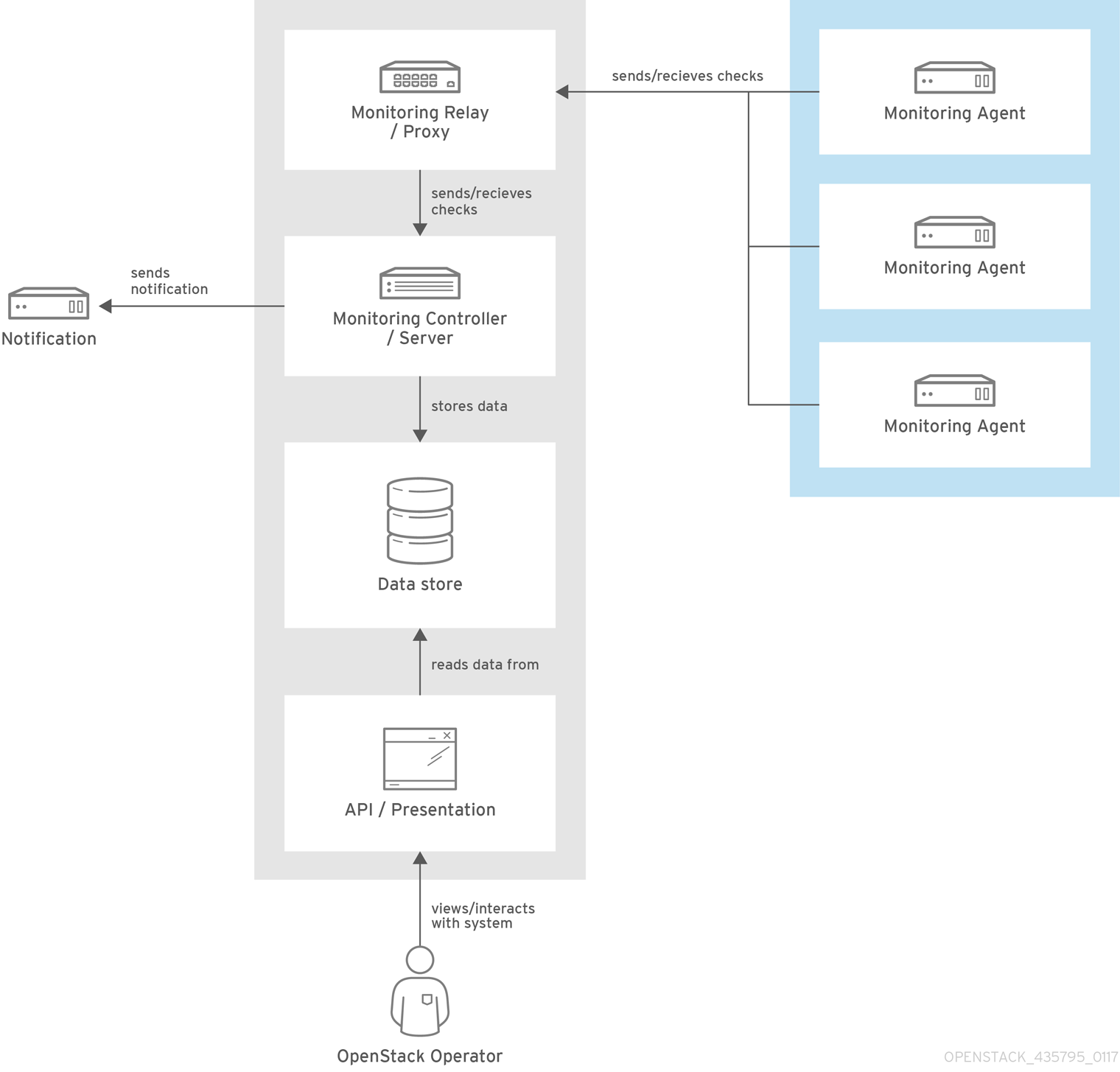

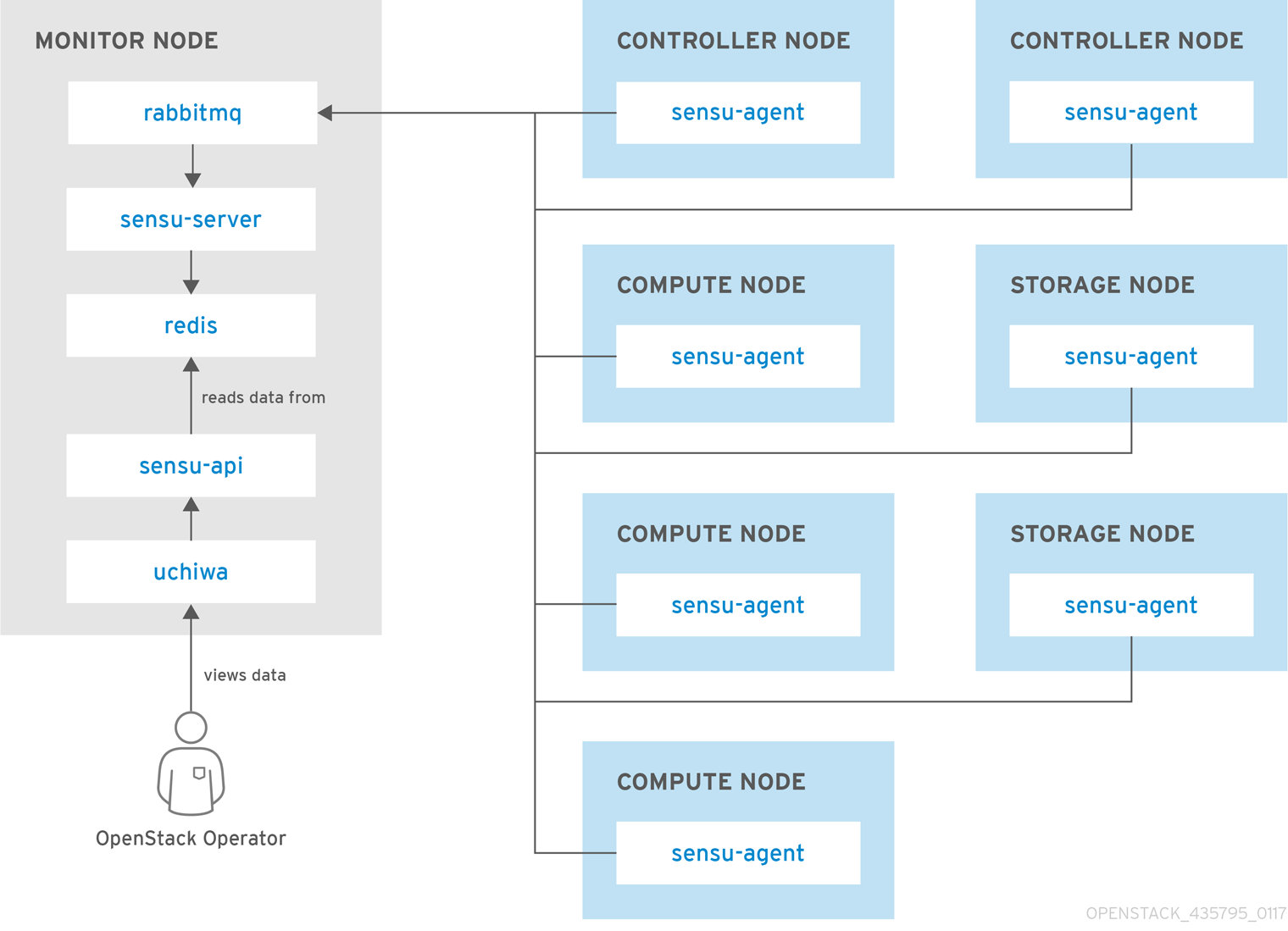

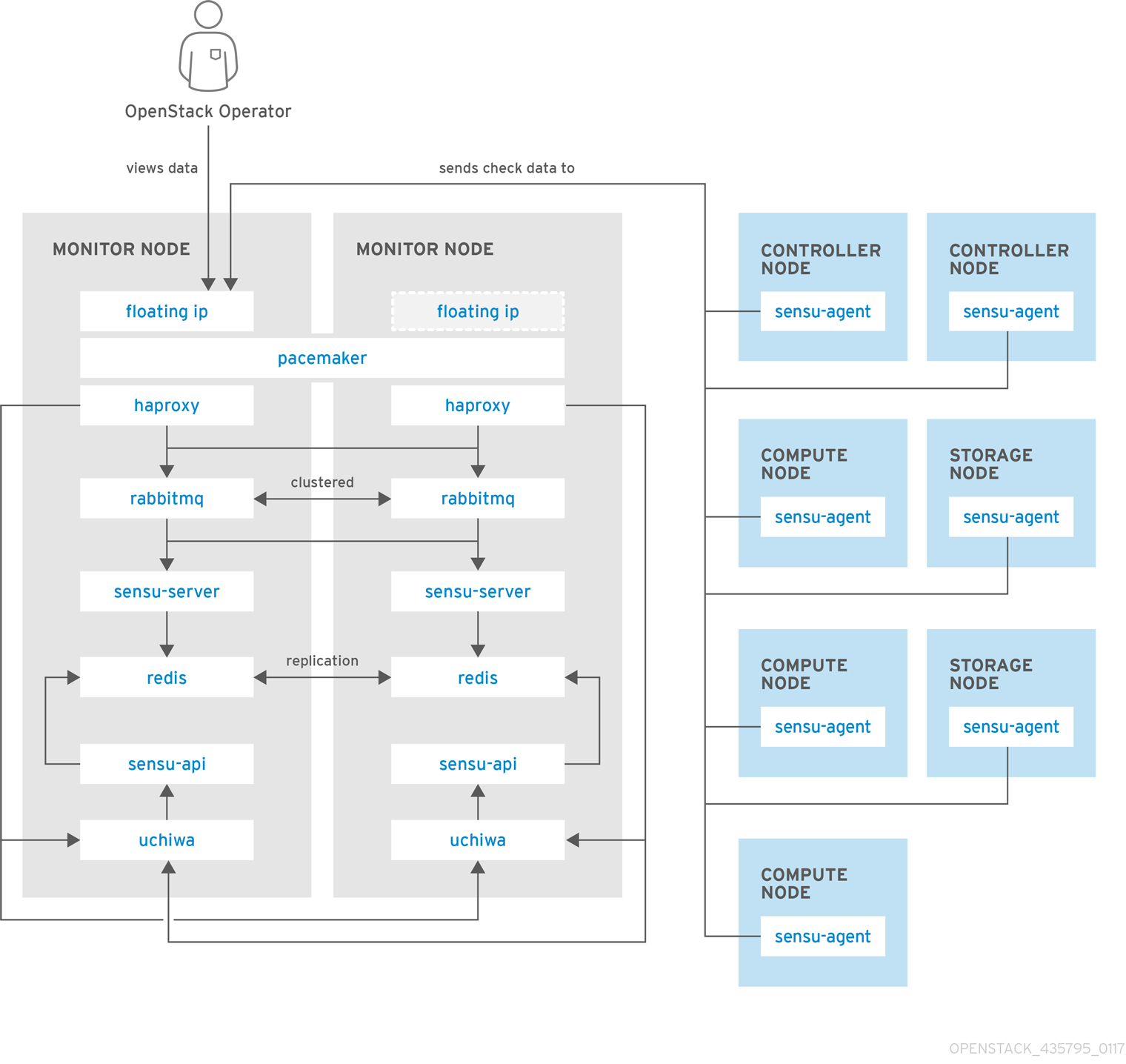

- OS::TripleO::Services::TripleoFirewall