네트워킹

AWS 네트워킹에서 Red Hat OpenShift Service 구성

초록

1장. AWS의 Red Hat OpenShift Service의 DNS Operator

AWS의 Red Hat OpenShift Service에서 DNS Operator는 CoreDNS 인스턴스를 배포 및 관리하여 클러스터 내부 Pod에 이름 확인 서비스를 제공하고 DNS 기반 Kubernetes 서비스 검색을 활성화하며 내부 cluster.local 이름을 확인합니다.

1.1. DNS 전달 사용

DNS 전달을 사용하여 다음과 같은 방법으로 /etc/resolv.conf 파일의 기본 전달 구성을 덮어쓸 수 있습니다.

모든 영역에 대해 이름 서버(

spec.servers)를 지정합니다. 전달된 영역이 AWS의 Red Hat OpenShift Service에서 관리하는 인그레스 도메인인 경우 도메인에 대한 업스트림 이름 서버를 인증해야 합니다.중요하나 이상의 영역을 지정해야 합니다. 그렇지 않으면 클러스터가 기능을 손실할 수 있습니다.

-

업스트림 DNS 서버 목록 제공(

spec.upstreamResolvers). - 기본 전달 정책을 변경합니다.

기본 도메인의 DNS 전달 구성에는 /etc/resolv.conf 파일과 업스트림 DNS 서버에 지정된 기본 서버가 모두 있을 수 있습니다.

프로세스

이름이

default인 DNS Operator 오브젝트를 수정합니다.$ oc edit dns.operator/default

이전 명령을 실행한 후 Operator는

spec.servers를 기반으로 추가 서버 구성 블록을 사용하여dns-default라는 구성 맵을 생성하고 업데이트합니다.중요zones매개 변수의 값을 지정할 때 인트라넷과 같은 특정 영역으로만 전달해야 합니다. 하나 이상의 영역을 지정해야 합니다. 그렇지 않으면 클러스터가 기능을 손실할 수 있습니다.서버에 쿼리와 일치하는 영역이 없는 경우 이름 확인은 업스트림 DNS 서버로 대체됩니다.

DNS 전달 구성

apiVersion: operator.openshift.io/v1 kind: DNS metadata: name: default spec: cache: negativeTTL: 0s positiveTTL: 0s logLevel: Normal nodePlacement: {} operatorLogLevel: Normal servers: - name: example-server 1 zones: - example.com 2 forwardPlugin: policy: Random 3 upstreams: 4 - 1.1.1.1 - 2.2.2.2:5353 upstreamResolvers: 5 policy: Random 6 protocolStrategy: "" 7 transportConfig: {} 8 upstreams: - type: SystemResolvConf 9 - type: Network address: 1.2.3.4 10 port: 53 11 status: clusterDomain: cluster.local clusterIP: x.y.z.10 conditions: ...- 1

rfc6335서비스 이름 구문을 준수해야 합니다.- 2

rfc1123서비스 이름 구문의 하위 도메인 정의를 준수해야 합니다. 클러스터 도메인인cluster.local은zones필드에 대해 유효하지 않은 하위 도메인입니다.- 3

forwardPlugin에 나열된 업스트림 리졸버를 선택하는 정책을 정의합니다. 기본값은Random입니다.RoundRobin및Sequential값을 사용할 수도 있습니다.- 4

forwardPlugin당 최대 15개의업스트림이 허용됩니다.- 5

upstreamResolvers를 사용하여 기본 전달 정책을 재정의하고 기본 도메인의 지정된 DNS 확인자(업스트림 확인자)로 DNS 확인을 전달할 수 있습니다. 업스트림 확인자를 제공하지 않으면 DNS 이름 쿼리는/etc/resolv.conf에 선언된 서버로 이동합니다.- 6

- 쿼리용으로 업스트림에 나열된

업스트림서버의 순서를 결정합니다. 이러한 값 중 하나를 지정할 수 있습니다.Random,RoundRobin또는Sequential. 기본값은Sequential입니다. - 7

- 생략하면 플랫폼은 원래 클라이언트 요청의 프로토콜인 기본값을 선택합니다. 클라이언트 요청이 UDP를 사용하는 경우에도 플랫폼에서 모든 업스트림 DNS 요청에

TCP를 사용하도록 지정하려면 TCP로 설정합니다. - 8

- DNS 요청을 업스트림 확인기로 전달할 때 사용할 전송 유형, 서버 이름 및 선택적 사용자 정의 CA 또는 CA 번들을 구성하는 데 사용됩니다.

- 9

- 두 가지 유형의

업스트림을 지정할 수 있습니다 :SystemResolvConf또는Network.SystemResolvConf는/etc/resolv.conf를 사용하도록 업스트림을 구성하고Network는Networkresolver를 정의합니다. 하나 또는 둘 다를 지정할 수 있습니다. - 10

- 지정된 유형이

Network인 경우 IP 주소를 제공해야 합니다.address필드는 유효한 IPv4 또는 IPv6 주소여야 합니다. - 11

- 지정된 유형이

네트워크인 경우 선택적으로 포트를 제공할 수 있습니다.port필드에는1에서65535사이의 값이 있어야 합니다. 업스트림에 대한 포트를 지정하지 않으면 기본 포트는 853입니다.

추가 리소스

- DNS 전달에 대한 자세한 내용은 CoreDNS 전달 설명서를 참조하십시오.

2장. AWS의 Red Hat OpenShift Service의 Ingress Operator

2.1. Red Hat OpenShift Service on AWS Ingress Operator

AWS 클러스터에서 Red Hat OpenShift Service를 생성할 때 클러스터에서 실행되는 Pod 및 서비스에는 각각 자체 IP 주소가 할당됩니다. IP 주소는 내부에서 실행되지만 외부 클라이언트가 액세스할 수 없는 다른 pod 및 서비스에 액세스할 수 있습니다. Ingress Operator는 IngressController API를 구현하며 AWS 클러스터 서비스에서 Red Hat OpenShift Service에 대한 외부 액세스를 활성화하는 구성 요소입니다.

Ingress Operator를 사용하면 라우팅을 처리하기 위해 하나 이상의 HAProxy 기반 Ingress 컨트롤러를 배포하고 관리하여 외부 클라이언트가 서비스에 액세스할 수 있습니다. Red Hat SRE(Site Reliability Engineer)는 AWS 클러스터에서 Red Hat OpenShift Service용 Ingress Operator를 관리합니다. Ingress Operator의 설정을 변경할 수는 없지만 기본 Ingress 컨트롤러 구성, 상태 및 로그와 Ingress Operator 상태를 볼 수 있습니다.

2.2. Ingress 구성 자산

설치 프로그램은 config.openshift.io API 그룹인 cluster-ingress-02-config.yml에 Ingress 리소스가 포함된 자산을 생성합니다.

Ingress 리소스의 YAML 정의

apiVersion: config.openshift.io/v1 kind: Ingress metadata: name: cluster spec: domain: apps.openshiftdemos.com

설치 프로그램은 이 자산을 manifests / 디렉터리의 cluster-ingress-02-config.yml 파일에 저장합니다. 이 Ingress 리소스는 Ingress와 관련된 전체 클러스터 구성을 정의합니다. 이 Ingress 구성은 다음과 같이 사용됩니다.

- Ingress Operator는 클러스터 Ingress 구성에 설정된 도메인을 기본 Ingress 컨트롤러의 도메인으로 사용합니다.

-

OpenShift API Server Operator는 클러스터 Ingress 구성의 도메인을 사용합니다. 이 도메인은 명시적 호스트를 지정하지 않는

Route리소스에 대한 기본 호스트를 생성할 수도 있습니다.

2.3. Ingress 컨트롤러 구성 매개변수

ingresscontrollers.operator.openshift.io 리소스에서 제공되는 구성 매개변수는 다음과 같습니다.

| 매개변수 | 설명 |

|---|---|

|

|

비어 있는 경우 기본값은 |

|

|

|

|

|

다음

설정되지 않은 경우, 기본값은

|

|

|

보안에는 키와 데이터, 즉 *

설정하지 않으면 와일드카드 인증서가 자동으로 생성되어 사용됩니다. 인증서는 Ingress 컨트롤러 생성된 인증서 또는 사용자 지정 인증서는 AWS 기본 제공 OAuth 서버의 Red Hat OpenShift Service와 자동으로 통합됩니다. |

|

|

|

|

|

|

|

|

설정하지 않으면 기본값이 사용됩니다. 참고

nodePlacement:

nodeSelector:

matchLabels:

kubernetes.io/os: linux

tolerations:

- effect: NoSchedule

operator: Exists |

|

|

설정되지 않으면, 기본값은

Ingress 컨트롤러의 최소 TLS 버전은 참고

구성된 보안 프로파일의 암호 및 최소 TLS 버전은 중요

Ingress Operator는 |

|

|

|

|

|

|

|

|

|

|

|

기본적으로 정책은

이러한 조정은 HTTP/1을 사용하는 경우에만 일반 텍스트, 에지 종료 및 재암호화 경로에 적용됩니다.

요청 헤더의 경우 이러한 조정은

|

|

|

|

|

|

|

|

|

캡처하려는 모든 쿠키의 경우 다음 매개변수가

예를 들면 다음과 같습니다. httpCaptureCookies:

- matchType: Exact

maxLength: 128

name: MYCOOKIE

|

|

|

httpCaptureHeaders:

request:

- maxLength: 256

name: Connection

- maxLength: 128

name: User-Agent

response:

- maxLength: 256

name: Content-Type

- maxLength: 256

name: Content-Length

|

|

|

|

|

|

|

|

|

이러한 연결은 로드 밸런서 상태 프로브 또는 웹 브라우저 추측 연결(preconnect)에서 제공되며 무시해도 됩니다. 그러나 이러한 요청은 네트워크 오류로 인해 발생할 수 있으므로 이 필드를 |

모든 매개변수는 선택 사항입니다.

2.3.1. Ingress 컨트롤러 TLS 보안 프로필

TLS 보안 프로필은 서버가 서버에 연결할 때 연결 클라이언트가 사용할 수 있는 암호를 규제하는 방법을 제공합니다.

2.3.1.1. TLS 보안 프로필 이해

TLS(Transport Layer Security) 보안 프로필을 사용하여 AWS 구성 요소의 다양한 Red Hat OpenShift Service에 필요한 TLS 암호를 정의할 수 있습니다. AWS TLS 보안 프로필의 Red Hat OpenShift Service는 Mozilla 권장 구성 을 기반으로 합니다.

각 구성 요소에 대해 다음 TLS 보안 프로필 중 하나를 지정할 수 있습니다.

표 2.1. TLS 보안 프로필

| Profile | 설명 |

|---|---|

|

| 이 프로필은 레거시 클라이언트 또는 라이브러리와 함께 사용하기 위한 것입니다. 프로필은 이전 버전과의 호환성 권장 구성을 기반으로 합니다.

참고 Ingress 컨트롤러의 경우 최소 TLS 버전이 1.0에서 1.1로 변환됩니다. |

|

| 이 프로필은 대부분의 클라이언트에서 권장되는 구성입니다. Ingress 컨트롤러, kubelet 및 컨트롤 플레인의 기본 TLS 보안 프로필입니다. 프로필은 중간 호환성 권장 구성을 기반으로 합니다.

|

|

| 이 프로필은 이전 버전과의 호환성이 필요하지 않은 최신 클라이언트와 사용하기 위한 것입니다. 이 프로필은 최신 호환성 권장 구성을 기반으로 합니다.

|

|

| 이 프로필을 사용하면 사용할 TLS 버전과 암호를 정의할 수 있습니다. 주의

|

미리 정의된 프로파일 유형 중 하나를 사용하는 경우 유효한 프로파일 구성은 릴리스마다 변경될 수 있습니다. 예를 들어 릴리스 X.Y.Z에 배포된 중간 프로필을 사용하는 사양이 있는 경우 릴리스 X.Y.Z+1로 업그레이드하면 새 프로필 구성이 적용되어 롤아웃이 발생할 수 있습니다.

2.3.1.2. Ingress 컨트롤러의 TLS 보안 프로필 구성

Ingress 컨트롤러에 대한 TLS 보안 프로필을 구성하려면 IngressController CR(사용자 정의 리소스)을 편집하여 사전 정의된 또는 사용자 지정 TLS 보안 프로필을 지정합니다. TLS 보안 프로필이 구성되지 않은 경우 기본값은 API 서버에 설정된 TLS 보안 프로필을 기반으로 합니다.

Old TLS 보안 프로파일을 구성하는 샘플 IngressController CR

apiVersion: operator.openshift.io/v1

kind: IngressController

...

spec:

tlsSecurityProfile:

old: {}

type: Old

...

TLS 보안 프로필은 Ingress 컨트롤러의 TLS 연결에 대한 최소 TLS 버전과 TLS 암호를 정의합니다.

Status.Tls Profile 아래의 IngressController CR(사용자 정의 리소스) 및 Spec.Tls Security Profile 아래 구성된 TLS 보안 프로필에서 구성된 TLS 보안 프로필의 암호 및 최소 TLS 버전을 확인할 수 있습니다. Custom TLS 보안 프로필의 경우 특정 암호 및 최소 TLS 버전이 두 매개변수 아래에 나열됩니다.

HAProxy Ingress 컨트롤러 이미지는 TLS 1.3 및 Modern 프로필을 지원합니다.

Ingress Operator는 Old 또는 Custom 프로파일의 TLS 1.0을 1.1로 변환합니다.

사전 요구 사항

-

cluster-admin역할의 사용자로 클러스터에 액세스할 수 있어야 합니다.

절차

openshift-ingress-operator프로젝트에서IngressControllerCR을 편집하여 TLS 보안 프로필을 구성합니다.$ oc edit IngressController default -n openshift-ingress-operator

spec.tlsSecurityProfile필드를 추가합니다.Custom프로필에 대한IngressControllerCR 샘플apiVersion: operator.openshift.io/v1 kind: IngressController ... spec: tlsSecurityProfile: type: Custom 1 custom: 2 ciphers: 3 - ECDHE-ECDSA-CHACHA20-POLY1305 - ECDHE-RSA-CHACHA20-POLY1305 - ECDHE-RSA-AES128-GCM-SHA256 - ECDHE-ECDSA-AES128-GCM-SHA256 minTLSVersion: VersionTLS11 ...- 파일을 저장하여 변경 사항을 적용합니다.

검증

IngressControllerCR에 프로파일이 설정되어 있는지 확인합니다.$ oc describe IngressController default -n openshift-ingress-operator

출력 예

Name: default Namespace: openshift-ingress-operator Labels: <none> Annotations: <none> API Version: operator.openshift.io/v1 Kind: IngressController ... Spec: ... Tls Security Profile: Custom: Ciphers: ECDHE-ECDSA-CHACHA20-POLY1305 ECDHE-RSA-CHACHA20-POLY1305 ECDHE-RSA-AES128-GCM-SHA256 ECDHE-ECDSA-AES128-GCM-SHA256 Min TLS Version: VersionTLS11 Type: Custom ...

2.3.1.3. 상호 TLS 인증 구성

spec.clientTLS 값을 설정하여 mTLS(mTLS) 인증을 사용하도록 Ingress 컨트롤러를 구성할 수 있습니다. clientTLS 값은 클라이언트 인증서를 확인하도록 Ingress 컨트롤러를 구성합니다. 이 구성에는 구성 맵에 대한 참조인 clientCA 값 설정이 포함됩니다. 구성 맵에는 클라이언트의 인증서를 확인하는 데 사용되는 PEM 인코딩 CA 인증서 번들이 포함되어 있습니다. 필요한 경우 인증서 제목 필터 목록을 구성할 수도 있습니다.

clientCA 값이 X509v3 인증서 취소 목록(CRL) 배포 지점을 지정하는 경우 Ingress Operator는 각 인증서에 지정된 HTTP URI X509v3 CRL Distribution Point 를 기반으로 CRL 구성 맵을 다운로드하고 관리합니다. Ingress 컨트롤러는 mTLS/TLS 협상 중에 이 구성 맵을 사용합니다. 유효한 인증서를 제공하지 않는 요청은 거부됩니다.

사전 요구 사항

-

cluster-admin역할의 사용자로 클러스터에 액세스할 수 있어야 합니다. - PEM 인코딩 CA 인증서 번들이 있습니다.

CA 번들이 CRL 배포 지점을 참조하는 경우 클라이언트 CA 번들에 엔드센티 또는 리프 인증서도 포함해야 합니다. RFC 5280에 설명된 대로 이 인증서에는

CRL 배포 지점아래에 HTTP URI가 포함되어 있어야 합니다. 예를 들면 다음과 같습니다.Issuer: C=US, O=Example Inc, CN=Example Global G2 TLS RSA SHA256 2020 CA1 Subject: SOME SIGNED CERT X509v3 CRL Distribution Points: Full Name: URI:http://crl.example.com/example.crl

절차

openshift-config네임스페이스에서 CA 번들에서 구성 맵을 생성합니다.$ oc create configmap \ router-ca-certs-default \ --from-file=ca-bundle.pem=client-ca.crt \1 -n openshift-config- 1

- 구성 맵 데이터 키는

ca-bundle.pem이어야 하며 데이터 값은 PEM 형식의 CA 인증서여야 합니다.

openshift-ingress-operator프로젝트에서IngressController리소스를 편집합니다.$ oc edit IngressController default -n openshift-ingress-operator

spec.clientTLS필드 및 하위 필드를 추가하여 상호 TLS를 구성합니다.패턴 필터링을 지정하는

clientTLS프로필에 대한IngressControllerCR 샘플apiVersion: operator.openshift.io/v1 kind: IngressController metadata: name: default namespace: openshift-ingress-operator spec: clientTLS: clientCertificatePolicy: Required clientCA: name: router-ca-certs-default allowedSubjectPatterns: - "^/CN=example.com/ST=NC/C=US/O=Security/OU=OpenShift$"

2.4. 기본 Ingress 컨트롤러 보기

Ingress Operator는 AWS의 Red Hat OpenShift Service의 핵심 기능이며 즉시 사용할 수 있습니다.

AWS의 모든 새로운 Red Hat OpenShift Service에는 이름이 default인 ingresscontroller 가 있습니다. 추가 Ingress 컨트롤러를 추가할 수 있습니다. 기본 ingresscontroller가 삭제되면 Ingress Operator가 1분 이내에 자동으로 다시 생성합니다.

프로세스

기본 Ingress 컨트롤러를 확인합니다.

$ oc describe --namespace=openshift-ingress-operator ingresscontroller/default

2.5. Ingress Operator 상태 보기

Ingress Operator의 상태를 확인 및 조사할 수 있습니다.

프로세스

Ingress Operator 상태를 확인합니다.

$ oc describe clusteroperators/ingress

2.6. Ingress 컨트롤러 로그 보기

Ingress 컨트롤러의 로그를 확인할 수 있습니다.

프로세스

Ingress 컨트롤러 로그를 확인합니다.

$ oc logs --namespace=openshift-ingress-operator deployments/ingress-operator -c <container_name>

2.7. Ingress 컨트롤러 상태 보기

특정 Ingress 컨트롤러의 상태를 확인할 수 있습니다.

프로세스

Ingress 컨트롤러의 상태를 확인합니다.

$ oc describe --namespace=openshift-ingress-operator ingresscontroller/<name>

2.8. Ingress 컨트롤러 구성

2.8.1. 사용자 정의 기본 인증서 설정

관리자는 Secret 리소스를 생성하고 IngressController CR(사용자 정의 리소스)을 편집하여 사용자 정의 인증서를 사용하도록 Ingress 컨트롤러를 구성할 수 있습니다.

사전 요구 사항

- PEM 인코딩 파일에 인증서/키 쌍이 있어야 합니다. 이때 인증서는 신뢰할 수 있는 인증 기관 또는 사용자 정의 PKI에서 구성한 신뢰할 수 있는 개인 인증 기관의 서명을 받은 인증서입니다.

인증서가 다음 요구 사항을 충족합니다.

- 인증서가 Ingress 도메인에 유효해야 합니다.

-

인증서는

subjectAltName확장자를 사용하여*.apps.ocp4.example.com과같은 와일드카드 도메인을 지정합니다.

IngressControllerCR이 있어야 합니다. 기본 설정을 사용할 수 있어야 합니다.$ oc --namespace openshift-ingress-operator get ingresscontrollers

출력 예

NAME AGE default 10m

임시 인증서가 있는 경우 사용자 정의 기본 인증서가 포함 된 보안의 tls.crt 파일에 인증서가 포함되어 있어야 합니다. 인증서를 지정하는 경우에는 순서가 중요합니다. 서버 인증서 다음에 임시 인증서를 나열해야 합니다.

절차

아래에서는 사용자 정의 인증서 및 키 쌍이 현재 작업 디렉터리의 tls.crt 및 tls.key 파일에 있다고 가정합니다. 그리고 tls.crt 및 tls.key의 실제 경로 이름으로 변경합니다. Secret 리소스를 생성하고 IngressController CR에서 참조하는 경우 custom-certs-default를 다른 이름으로 변경할 수도 있습니다.

이 작업을 수행하면 롤링 배포 전략에 따라 Ingress 컨트롤러가 재배포됩니다.

tls.crt및tls.key파일을 사용하여openshift-ingress네임스페이스에 사용자 정의 인증서를 포함하는 Secret 리소스를 만듭니다.$ oc --namespace openshift-ingress create secret tls custom-certs-default --cert=tls.crt --key=tls.key

새 인증서 보안 키를 참조하도록 IngressController CR을 업데이트합니다.

$ oc patch --type=merge --namespace openshift-ingress-operator ingresscontrollers/default \ --patch '{"spec":{"defaultCertificate":{"name":"custom-certs-default"}}}'업데이트가 적용되었는지 확인합니다.

$ echo Q |\ openssl s_client -connect console-openshift-console.apps.<domain>:443 -showcerts 2>/dev/null |\ openssl x509 -noout -subject -issuer -enddate

다음과 같습니다.

<domain>- 클러스터의 기본 도메인 이름을 지정합니다.

출력 예

subject=C = US, ST = NC, L = Raleigh, O = RH, OU = OCP4, CN = *.apps.example.com issuer=C = US, ST = NC, L = Raleigh, O = RH, OU = OCP4, CN = example.com notAfter=May 10 08:32:45 2022 GM

작은 정보다음 YAML을 적용하여 사용자 지정 기본 인증서를 설정할 수 있습니다.

apiVersion: operator.openshift.io/v1 kind: IngressController metadata: name: default namespace: openshift-ingress-operator spec: defaultCertificate: name: custom-certs-default인증서 보안 이름은 CR을 업데이트하는 데 사용된 값과 일치해야 합니다.

IngressController CR이 수정되면 Ingress Operator는 사용자 정의 인증서를 사용하도록 Ingress 컨트롤러의 배포를 업데이트합니다.

2.8.2. 사용자 정의 기본 인증서 제거

관리자는 사용할 Ingress 컨트롤러를 구성한 사용자 정의 인증서를 제거할 수 있습니다.

사전 요구 사항

-

cluster-admin역할의 사용자로 클러스터에 액세스할 수 있어야 합니다. -

OpenShift CLI(

oc)가 설치되어 있습니다. - 이전에는 Ingress 컨트롤러에 대한 사용자 정의 기본 인증서를 구성했습니다.

절차

사용자 정의 인증서를 제거하고 AWS에서 Red Hat OpenShift Service와 함께 제공되는 인증서를 복원하려면 다음 명령을 입력합니다.

$ oc patch -n openshift-ingress-operator ingresscontrollers/default \ --type json -p $'- op: remove\n path: /spec/defaultCertificate'

클러스터가 새 인증서 구성을 조정하는 동안 지연이 발생할 수 있습니다.

검증

원래 클러스터 인증서가 복원되었는지 확인하려면 다음 명령을 입력합니다.

$ echo Q | \ openssl s_client -connect console-openshift-console.apps.<domain>:443 -showcerts 2>/dev/null | \ openssl x509 -noout -subject -issuer -enddate

다음과 같습니다.

<domain>- 클러스터의 기본 도메인 이름을 지정합니다.

출력 예

subject=CN = *.apps.<domain> issuer=CN = ingress-operator@1620633373 notAfter=May 10 10:44:36 2023 GMT

2.8.3. Ingress 컨트롤러 자동 스케일링

처리량 증가 요구와 같은 라우팅 성능 또는 가용성 요구 사항을 동적으로 충족하도록 Ingress 컨트롤러를 자동으로 확장합니다. 다음 절차는 기본 IngressController를 확장하는 예제입니다.

사전 요구 사항

-

OpenShift CLI(

oc)가 설치되어 있어야 합니다. -

cluster-admin역할의 사용자로 AWS 클러스터의 Red Hat OpenShift Service에 액세스할 수 있습니다. - Custom Metrics Autoscaler Operator가 설치되어 있습니다.

-

openshift-ingress-operator프로젝트 네임스페이스에 있습니다.

절차

다음 명령을 실행하여 Thanos로 인증할 서비스 계정을 생성합니다.

$ oc create serviceaccount thanos && oc describe serviceaccount thanos

출력 예

Name: thanos Namespace: openshift-ingress-operator Labels: <none> Annotations: <none> Image pull secrets: thanos-dockercfg-b4l9s Mountable secrets: thanos-dockercfg-b4l9s Tokens: thanos-token-c422q Events: <none>

서비스 계정의 토큰을 사용하여

openshift-ingress-operator네임스페이스에TriggerAuthentication오브젝트를 정의합니다.다음 명령을 실행하여

시크릿이 포함된 변수 보안을 정의합니다.$ secret=$(oc get secret | grep thanos-token | head -n 1 | awk '{ print $1 }')TriggerAuthentication오브젝트를 생성하고secret변수 값을TOKEN매개변수에 전달합니다.$ oc process TOKEN="$secret" -f - <<EOF | oc apply -f - apiVersion: template.openshift.io/v1 kind: Template parameters: - name: TOKEN objects: - apiVersion: keda.sh/v1alpha1 kind: TriggerAuthentication metadata: name: keda-trigger-auth-prometheus spec: secretTargetRef: - parameter: bearerToken name: \${TOKEN} key: token - parameter: ca name: \${TOKEN} key: ca.crt EOF

Thanos에서 메트릭을 읽는 역할을 생성하고 적용합니다.

Pod 및 노드에서 지표를 읽는 새 역할

thanos-metrics-reader.yaml을 생성합니다.thanos-metrics-reader.yaml

apiVersion: rbac.authorization.k8s.io/v1 kind: Role metadata: name: thanos-metrics-reader rules: - apiGroups: - "" resources: - pods - nodes verbs: - get - apiGroups: - metrics.k8s.io resources: - pods - nodes verbs: - get - list - watch - apiGroups: - "" resources: - namespaces verbs: - get

다음 명령을 실행하여 새 역할을 적용합니다.

$ oc apply -f thanos-metrics-reader.yaml

다음 명령을 입력하여 서비스 계정에 새 역할을 추가합니다.

$ oc adm policy add-role-to-user thanos-metrics-reader -z thanos --role-namespace=openshift-ingress-operator

$ oc adm policy -n openshift-ingress-operator add-cluster-role-to-user cluster-monitoring-view -z thanos

참고add-cluster-role-to-user인수는 네임스페이스 간 쿼리를 사용하는 경우에만 필요합니다. 다음 단계에서는 이 인수가 필요한kube-metrics네임스페이스의 쿼리를 사용합니다.기본 Ingress 컨트롤러 배포를 대상으로 하는 새 scaled

ObjectYAML 파일ingress-autoscaler.yaml을 만듭니다.scaled

Object정의의 예apiVersion: keda.sh/v1alpha1 kind: ScaledObject metadata: name: ingress-scaler spec: scaleTargetRef: 1 apiVersion: operator.openshift.io/v1 kind: IngressController name: default envSourceContainerName: ingress-operator minReplicaCount: 1 maxReplicaCount: 20 2 cooldownPeriod: 1 pollingInterval: 1 triggers: - type: prometheus metricType: AverageValue metadata: serverAddress: https://thanos-querier.openshift-monitoring.svc.cluster.local:9091 3 namespace: openshift-ingress-operator 4 metricName: 'kube-node-role' threshold: '1' query: 'sum(kube_node_role{role="worker",service="kube-state-metrics"})' 5 authModes: "bearer" authenticationRef: name: keda-trigger-auth-prometheus

중요네임스페이스 간 쿼리를 사용하는 경우

serverAddress필드에서 포트 9091이 아닌 포트 9091을 대상으로 지정해야 합니다. 또한 이 포트에서 메트릭을 읽을 수 있는 높은 권한이 있어야 합니다.다음 명령을 실행하여 사용자 정의 리소스 정의를 적용합니다.

$ oc apply -f ingress-autoscaler.yaml

검증

다음 명령을 실행하여 기본 Ingress 컨트롤러가

kube-state-metrics쿼리에서 반환된 값과 일치하도록 확장되었는지 확인합니다.grep명령을 사용하여 Ingress 컨트롤러 YAML 파일에서 복제본을 검색합니다.$ oc get ingresscontroller/default -o yaml | grep replicas:

출력 예

replicas: 3

openshift-ingress프로젝트에서 Pod를 가져옵니다.$ oc get pods -n openshift-ingress

출력 예

NAME READY STATUS RESTARTS AGE router-default-7b5df44ff-l9pmm 2/2 Running 0 17h router-default-7b5df44ff-s5sl5 2/2 Running 0 3d22h router-default-7b5df44ff-wwsth 2/2 Running 0 66s

2.8.4. Ingress 컨트롤러 확장

처리량 증가 요구 등 라우팅 성능 또는 가용성 요구 사항을 충족하도록 Ingress 컨트롤러를 수동으로 확장할 수 있습니다. IngressController 리소스를 확장하려면 oc 명령을 사용합니다. 다음 절차는 기본 IngressController를 확장하는 예제입니다.

원하는 수의 복제본을 만드는 데에는 시간이 걸리기 때문에 확장은 즉시 적용되지 않습니다.

절차

기본

IngressController의 현재 사용 가능한 복제본 개수를 살펴봅니다.$ oc get -n openshift-ingress-operator ingresscontrollers/default -o jsonpath='{$.status.availableReplicas}'출력 예

2

oc patch명령을 사용하여 기본IngressController의 복제본 수를 원하는 대로 조정합니다. 다음 예제는 기본IngressController를 3개의 복제본으로 조정합니다.$ oc patch -n openshift-ingress-operator ingresscontroller/default --patch '{"spec":{"replicas": 3}}' --type=merge출력 예

ingresscontroller.operator.openshift.io/default patched

기본

IngressController가 지정한 복제본 수에 맞게 조정되었는지 확인합니다.$ oc get -n openshift-ingress-operator ingresscontrollers/default -o jsonpath='{$.status.availableReplicas}'출력 예

3

작은 정보또는 다음 YAML을 적용하여 Ingress 컨트롤러를 세 개의 복제본으로 확장할 수 있습니다.

apiVersion: operator.openshift.io/v1 kind: IngressController metadata: name: default namespace: openshift-ingress-operator spec: replicas: 3 1- 1

- 다른 양의 복제본이 필요한 경우

replicas값을 변경합니다.

2.8.5. 수신 액세스 로깅 구성

Ingress 컨트롤러가 로그에 액세스하도록 구성할 수 있습니다. 수신 트래픽이 많지 않은 클러스터의 경우 사이드카에 로그를 기록할 수 있습니다. 트래픽이 많은 클러스터가 있는 경우 로깅 스택의 용량을 초과하지 않거나 AWS의 Red Hat OpenShift Service 외부에서 로깅 인프라와 통합하기 위해 사용자 정의 syslog 끝점으로 로그를 전달할 수 있습니다. 액세스 로그의 형식을 지정할 수도 있습니다.

컨테이너 로깅은 기존 Syslog 로깅 인프라가 없는 경우 트래픽이 적은 클러스터에서 액세스 로그를 활성화하거나 Ingress 컨트롤러의 문제를 진단하는 동안 단기적으로 사용하는 데 유용합니다.

액세스 로그가 OpenShift 로깅 스택 용량을 초과할 수 있는 트래픽이 많은 클러스터 또는 로깅 솔루션이 기존 Syslog 로깅 인프라와 통합되어야 하는 환경에는 Syslog가 필요합니다. Syslog 사용 사례는 중첩될 수 있습니다.

사전 요구 사항

-

cluster-admin권한이 있는 사용자로 로그인합니다.

절차

사이드카에 Ingress 액세스 로깅을 구성합니다.

수신 액세스 로깅을 구성하려면

spec.logging.access.destination을 사용하여 대상을 지정해야 합니다. 사이드카 컨테이너에 로깅을 지정하려면Containerspec.logging.access.destination.type을 지정해야 합니다. 다음 예제는Container대상에 로그를 기록하는 Ingress 컨트롤러 정의입니다.apiVersion: operator.openshift.io/v1 kind: IngressController metadata: name: default namespace: openshift-ingress-operator spec: replicas: 2 logging: access: destination: type: Container사이드카에 로그를 기록하도록 Ingress 컨트롤러를 구성하면 Operator는 Ingress 컨트롤러 Pod에

logs라는 컨테이너를 만듭니다.$ oc -n openshift-ingress logs deployment.apps/router-default -c logs

출력 예

2020-05-11T19:11:50.135710+00:00 router-default-57dfc6cd95-bpmk6 router-default-57dfc6cd95-bpmk6 haproxy[108]: 174.19.21.82:39654 [11/May/2020:19:11:50.133] public be_http:hello-openshift:hello-openshift/pod:hello-openshift:hello-openshift:10.128.2.12:8080 0/0/1/0/1 200 142 - - --NI 1/1/0/0/0 0/0 "GET / HTTP/1.1"

Syslog 끝점에 대한 Ingress 액세스 로깅을 구성합니다.

수신 액세스 로깅을 구성하려면

spec.logging.access.destination을 사용하여 대상을 지정해야 합니다. Syslog 끝점 대상에 로깅을 지정하려면spec.logging.access.destination.type에 대한Syslog를 지정해야 합니다. 대상 유형이Syslog인 경우,spec.logging.access.destination.syslog.endpoint를 사용하여 대상 끝점을 지정해야 하며spec.logging.access.destination.syslog.facility를 사용하여 장치를 지정할 수 있습니다. 다음 예제는Syslog대상에 로그를 기록하는 Ingress 컨트롤러 정의입니다.apiVersion: operator.openshift.io/v1 kind: IngressController metadata: name: default namespace: openshift-ingress-operator spec: replicas: 2 logging: access: destination: type: Syslog syslog: address: 1.2.3.4 port: 10514참고syslog대상 포트는 UDP여야 합니다.

특정 로그 형식으로 Ingress 액세스 로깅을 구성합니다.

spec.logging.access.httpLogFormat을 지정하여 로그 형식을 사용자 정의할 수 있습니다. 다음 예제는 IP 주소 1.2.3.4 및 포트 10514를 사용하여syslog끝점에 로그하는 Ingress 컨트롤러 정의입니다.apiVersion: operator.openshift.io/v1 kind: IngressController metadata: name: default namespace: openshift-ingress-operator spec: replicas: 2 logging: access: destination: type: Syslog syslog: address: 1.2.3.4 port: 10514 httpLogFormat: '%ci:%cp [%t] %ft %b/%s %B %bq %HM %HU %HV'

Ingress 액세스 로깅을 비활성화합니다.

Ingress 액세스 로깅을 비활성화하려면

spec.logging또는spec.logging.access를 비워 둡니다.apiVersion: operator.openshift.io/v1 kind: IngressController metadata: name: default namespace: openshift-ingress-operator spec: replicas: 2 logging: access: null

사이드카를 사용할 때 Ingress 컨트롤러에서 HAProxy 로그 길이를 수정할 수 있도록 허용합니다.

spec.logging.access.destination.destination.를 사용합니다.type: Syslog를 사용하는 경우 spec.logging.access.destination.maxLengthapiVersion: operator.openshift.io/v1 kind: IngressController metadata: name: default namespace: openshift-ingress-operator spec: replicas: 2 logging: access: destination: type: Syslog syslog: address: 1.2.3.4 maxLength: 4096 port: 10514spec.logging.access.destination.destination.를 사용합니다.type: Container를 사용하는 경우 spec.logging.access.destination.maxLengthapiVersion: operator.openshift.io/v1 kind: IngressController metadata: name: default namespace: openshift-ingress-operator spec: replicas: 2 logging: access: destination: type: Container container: maxLength: 8192

2.8.6. Ingress 컨트롤러 스레드 수 설정

클러스터 관리자는 클러스터에서 처리할 수 있는 들어오는 연결의 양을 늘리기 위해 스레드 수를 설정할 수 있습니다. 기존 Ingress 컨트롤러에 패치하여 스레드의 양을 늘릴 수 있습니다.

사전 요구 사항

- 다음은 Ingress 컨트롤러를 이미 생성했다고 가정합니다.

절차

스레드 수를 늘리도록 Ingress 컨트롤러를 업데이트합니다.

$ oc -n openshift-ingress-operator patch ingresscontroller/default --type=merge -p '{"spec":{"tuningOptions": {"threadCount": 8}}}'참고많은 리소스를 실행할 수 있는 노드가 있는 경우 원하는 노드의 용량과 일치하는 라벨을 사용하여

spec.nodePlacement.nodeSelector를 구성하고spec.tuningOptions.threadCount를 적절하게 높은 값으로 구성할 수 있습니다.

2.8.7. 내부 로드 밸런서를 사용하도록 Ingress 컨트롤러 구성

클라우드 플랫폼에서 Ingress 컨트롤러를 생성할 때 Ingress 컨트롤러는 기본적으로 퍼블릭 클라우드 로드 밸런서에 의해 게시됩니다. 관리자는 내부 클라우드 로드 밸런서를 사용하는 Ingress 컨트롤러를 생성할 수 있습니다.

IngressController 의 범위를 변경하려면 CR(사용자 정의 리소스)을 생성한 후 .spec.endpointPublishingStrategy.loadBalancer.scope 매개변수를 변경할 수 있습니다.

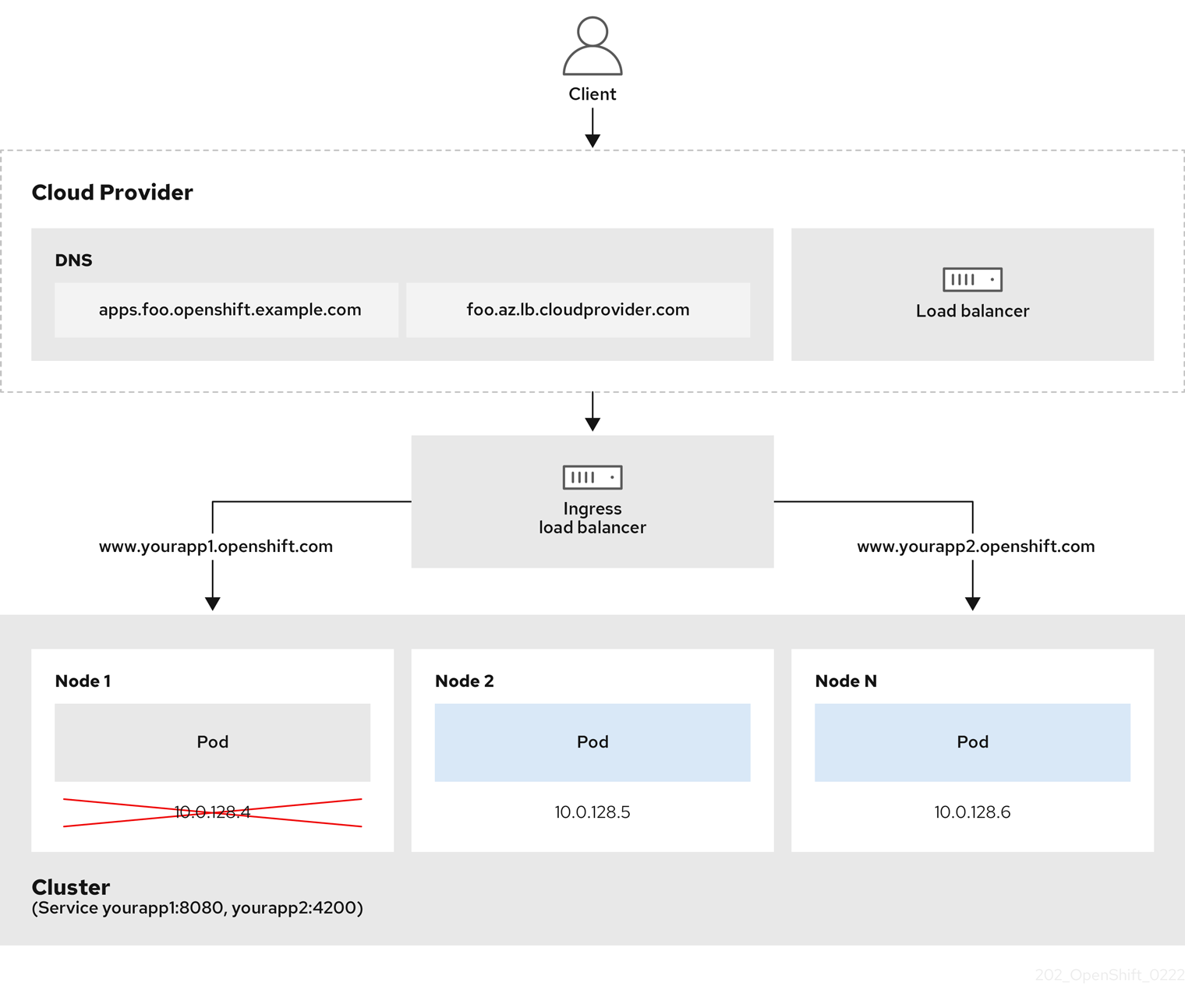

그림 2.1. LoadBalancer 다이어그램

이전 그래픽은 AWS Ingress LoadBalancerService 끝점 게시 전략의 Red Hat OpenShift Service와 관련된 다음 개념을 보여줍니다.

- 클라우드 공급자 로드 밸런서를 사용하거나 내부적으로 OpenShift Ingress 컨트롤러 로드 밸런서를 사용하여 외부에서 부하를 분산할 수 있습니다.

- 그래픽에 표시된 클러스터에 표시된 대로 로드 밸런서의 단일 IP 주소와 8080 및 4200과 같은 더 친숙한 포트를 사용할 수 있습니다.

- 외부 로드 밸런서의 트래픽은 Pod에서 전달되고 다운 노드의 인스턴스에 표시된 대로 로드 밸런서에 의해 관리됩니다. 구현 세부 사항은 Kubernetes 서비스 설명서를 참조하십시오.

사전 요구 사항

-

OpenShift CLI(

oc)를 설치합니다. -

cluster-admin권한이 있는 사용자로 로그인합니다.

절차

다음 예제와 같이

<name>-ingress-controller.yam파일에IngressControllerCR(사용자 정의 리소스)을 생성합니다.apiVersion: operator.openshift.io/v1 kind: IngressController metadata: namespace: openshift-ingress-operator name: <name> 1 spec: domain: <domain> 2 endpointPublishingStrategy: type: LoadBalancerService loadBalancer: scope: Internal 3

다음 명령을 실행하여 이전 단계에서 정의된 Ingress 컨트롤러를 생성합니다.

$ oc create -f <name>-ingress-controller.yaml 1- 1

<name>을IngressController오브젝트의 이름으로 변경합니다.

선택 사항: Ingress 컨트롤러가 생성되었는지 확인하려면 다음 명령을 실행합니다.

$ oc --all-namespaces=true get ingresscontrollers

2.8.8. Ingress 컨트롤러 상태 점검 간격 설정

클러스터 관리자는 상태 점검 간격을 설정하여 라우터가 연속 상태 점검 사이에 대기하는 시간을 정의할 수 있습니다. 이 값은 모든 경로에 대해 전역적으로 적용됩니다. 기본값은 5초입니다.

사전 요구 사항

- 다음은 Ingress 컨트롤러를 이미 생성했다고 가정합니다.

절차

백엔드 상태 점검 간 간격을 변경하도록 Ingress 컨트롤러를 업데이트합니다.

$ oc -n openshift-ingress-operator patch ingresscontroller/default --type=merge -p '{"spec":{"tuningOptions": {"healthCheckInterval": "8s"}}}'참고단일 경로의

healthCheckInterval을 재정의하려면 경로 주석router.openshift.io/haproxy.health.check.interval을 사용합니다.

2.8.9. 클러스터의 기본 Ingress 컨트롤러를 내부로 구성

클러스터를 삭제하고 다시 생성하여 클러스터의 default Ingress 컨트롤러를 내부용으로 구성할 수 있습니다.

IngressController 의 범위를 변경하려면 CR(사용자 정의 리소스)을 생성한 후 .spec.endpointPublishingStrategy.loadBalancer.scope 매개변수를 변경할 수 있습니다.

사전 요구 사항

-

OpenShift CLI(

oc)를 설치합니다. -

cluster-admin권한이 있는 사용자로 로그인합니다.

절차

클러스터의

기본Ingress 컨트롤러를 삭제하고 다시 생성하여 내부용으로 구성합니다.$ oc replace --force --wait --filename - <<EOF apiVersion: operator.openshift.io/v1 kind: IngressController metadata: namespace: openshift-ingress-operator name: default spec: endpointPublishingStrategy: type: LoadBalancerService loadBalancer: scope: Internal EOF

2.8.10. 경로 허용 정책 구성

관리자 및 애플리케이션 개발자는 도메인 이름이 동일한 여러 네임스페이스에서 애플리케이션을 실행할 수 있습니다. 이는 여러 팀이 동일한 호스트 이름에 노출되는 마이크로 서비스를 개발하는 조직을 위한 것입니다.

네임스페이스 간 클레임은 네임스페이스 간 신뢰가 있는 클러스터에 대해서만 허용해야 합니다. 그렇지 않으면 악의적인 사용자가 호스트 이름을 인수할 수 있습니다. 따라서 기본 승인 정책에서는 네임스페이스 간에 호스트 이름 클레임을 허용하지 않습니다.

사전 요구 사항

- 클러스터 관리자 권한이 있어야 합니다.

절차

다음 명령을 사용하여

ingresscontroller리소스 변수의.spec.routeAdmission필드를 편집합니다.$ oc -n openshift-ingress-operator patch ingresscontroller/default --patch '{"spec":{"routeAdmission":{"namespaceOwnership":"InterNamespaceAllowed"}}}' --type=merge샘플 Ingress 컨트롤러 구성

spec: routeAdmission: namespaceOwnership: InterNamespaceAllowed ...작은 정보다음 YAML을 적용하여 경로 승인 정책을 구성할 수 있습니다.

apiVersion: operator.openshift.io/v1 kind: IngressController metadata: name: default namespace: openshift-ingress-operator spec: routeAdmission: namespaceOwnership: InterNamespaceAllowed

2.8.11. 와일드카드 경로 사용

HAProxy Ingress 컨트롤러는 와일드카드 경로를 지원합니다. Ingress Operator는 wildcardPolicy를 사용하여 Ingress 컨트롤러의 ROUTER_ALLOW_WILDCARD_ROUTES 환경 변수를 구성합니다.

Ingress 컨트롤러의 기본 동작은 와일드카드 정책이 None인 경로를 허용하고, 이는 기존 IngressController 리소스의 이전 버전과 호환됩니다.

절차

와일드카드 정책을 구성합니다.

다음 명령을 사용하여

IngressController리소스를 편집합니다.$ oc edit IngressController

spec에서wildcardPolicy필드를WildcardsDisallowed또는WildcardsAllowed로 설정합니다.spec: routeAdmission: wildcardPolicy: WildcardsDisallowed # or WildcardsAllowed

2.8.12. HTTP 헤더 구성

Red Hat OpenShift Service on AWS는 HTTP 헤더로 작업할 수 있는 다양한 방법을 제공합니다. 헤더를 설정하거나 삭제할 때 Ingress 컨트롤러의 특정 필드를 사용하거나 개별 경로를 사용하여 요청 및 응답 헤더를 수정할 수 있습니다. 경로 주석을 사용하여 특정 헤더를 설정할 수도 있습니다. 헤더를 구성하는 다양한 방법은 함께 작업할 때 문제가 발생할 수 있습니다.

IngressController 또는 Route CR 내에서 헤더만 설정하거나 삭제할 수 있으므로 추가할 수 없습니다. HTTP 헤더가 값으로 설정된 경우 해당 값은 완료되어야 하며 나중에 추가할 필요가 없습니다. X-Forwarded-For 헤더와 같은 헤더를 추가하는 것이 적합한 경우 spec.httpHeaders.actions 대신 spec.httpHeaders.forwardedHeaderPolicy 필드를 사용합니다.

2.8.12.1. 우선순위 순서

Ingress 컨트롤러와 경로에서 동일한 HTTP 헤더를 수정하는 경우 HAProxy는 요청 또는 응답 헤더인지 여부에 따라 특정 방식으로 작업에 우선순위를 부여합니다.

- HTTP 응답 헤더의 경우 경로에 지정된 작업 후에 Ingress 컨트롤러에 지정된 작업이 실행됩니다. 즉, Ingress 컨트롤러에 지정된 작업이 우선합니다.

- HTTP 요청 헤더의 경우 경로에 지정된 작업은 Ingress 컨트롤러에 지정된 작업 후에 실행됩니다. 즉, 경로에 지정된 작업이 우선합니다.

예를 들어 클러스터 관리자는 다음 구성을 사용하여 Ingress 컨트롤러에서 값이 DENY 인 X-Frame-Options 응답 헤더를 설정합니다.

IngressController 사양 예

apiVersion: operator.openshift.io/v1

kind: IngressController

# ...

spec:

httpHeaders:

actions:

response:

- name: X-Frame-Options

action:

type: Set

set:

value: DENY

경로 소유자는 클러스터 관리자가 Ingress 컨트롤러에 설정한 것과 동일한 응답 헤더를 설정하지만 다음 구성을 사용하여 SAMEORIGIN 값이 사용됩니다.

Route 사양의 예

apiVersion: route.openshift.io/v1

kind: Route

# ...

spec:

httpHeaders:

actions:

response:

- name: X-Frame-Options

action:

type: Set

set:

value: SAMEORIGIN

IngressController 사양과 Route 사양 모두에서 X-Frame-Options 헤더를 구성하는 경우 특정 경로에서 프레임을 허용하는 경우에도 Ingress 컨트롤러의 글로벌 수준에서 이 헤더에 설정된 값이 우선합니다.

이 우선순위는 haproxy.config 파일에서 다음 논리를 사용하므로 Ingress 컨트롤러가 프런트 엔드로 간주되고 개별 경로가 백엔드로 간주되기 때문에 발생합니다. 프런트 엔드 구성에 적용된 헤더 값 DENY 는 백엔드에 설정된 SAMEORIGIN 값으로 동일한 헤더를 재정의합니다.

frontend public http-response set-header X-Frame-Options 'DENY' frontend fe_sni http-response set-header X-Frame-Options 'DENY' frontend fe_no_sni http-response set-header X-Frame-Options 'DENY' backend be_secure:openshift-monitoring:alertmanager-main http-response set-header X-Frame-Options 'SAMEORIGIN'

또한 Ingress 컨트롤러 또는 경로 주석을 사용하여 설정된 경로 덮어쓰기 값에 정의된 모든 작업입니다.

2.8.12.2. 특수 케이스 헤더

다음 헤더는 완전히 설정되거나 삭제되지 않거나 특정 상황에서 허용되지 않습니다.

표 2.2. 특수 케이스 헤더 구성 옵션

| 헤더 이름 | IngressController 사양을 사용하여 구성 가능 | Route 사양을 사용하여 구성 가능 | 허용하지 않는 이유 | 다른 방법을 사용하여 구성 가능 |

|---|---|---|---|---|

|

| 없음 | 없음 |

| 없음 |

|

| 없음 | 제공됨 |

| 없음 |

|

| 없음 | 없음 |

|

제공됨: |

|

| 없음 | 없음 | HAProxy가 클라이언트 연결을 특정 백엔드 서버에 매핑하는 세션 추적에 사용되는 쿠키입니다. 이러한 헤더를 설정하도록 허용하면 HAProxy의 세션 선호도를 방해하고 HAProxy의 쿠키 소유권을 제한할 수 있습니다. | 예:

|

2.8.13. Ingress 컨트롤러에서 HTTP 요청 및 응답 헤더 설정 또는 삭제

규정 준수 목적 또는 기타 이유로 특정 HTTP 요청 및 응답 헤더를 설정하거나 삭제할 수 있습니다. Ingress 컨트롤러에서 제공하는 모든 경로 또는 특정 경로에 대해 이러한 헤더를 설정하거나 삭제할 수 있습니다.

예를 들어 상호 TLS를 사용하기 위해 클러스터에서 실행 중인 애플리케이션을 마이그레이션할 수 있습니다. 이 경우 애플리케이션에서 X-Forwarded-Client-Cert 요청 헤더를 확인해야 하지만 AWS 기본 Ingress 컨트롤러의 Red Hat OpenShift Service는 X-SSL-Client-Der 요청 헤더를 제공합니다.

다음 절차에서는 X-Forwarded-Client-Cert 요청 헤더를 설정하도록 Ingress 컨트롤러를 수정하고 X-SSL-Client-Der 요청 헤더를 삭제합니다.

사전 요구 사항

-

OpenShift CLI(

oc)가 설치되어 있습니다. -

cluster-admin역할의 사용자로 AWS 클러스터의 Red Hat OpenShift Service에 액세스할 수 있습니다.

절차

Ingress 컨트롤러 리소스를 편집합니다.

$ oc -n openshift-ingress-operator edit ingresscontroller/default

X-SSL-Client-Der HTTP 요청 헤더를 X-Forwarded-Client-Cert HTTP 요청 헤더로 바꿉니다.

apiVersion: operator.openshift.io/v1 kind: IngressController metadata: name: default namespace: openshift-ingress-operator spec: httpHeaders: actions: 1 request: 2 - name: X-Forwarded-Client-Cert 3 action: type: Set 4 set: value: "%{+Q}[ssl_c_der,base64]" 5 - name: X-SSL-Client-Der action: type: Delete- 1

- HTTP 헤더에서 수행할 작업 목록입니다.

- 2

- 변경할 헤더 유형입니다. 이 경우 요청 헤더가 있습니다.

- 3

- 변경할 헤더의 이름입니다. 설정하거나 삭제할 수 있는 사용 가능한 헤더 목록은 HTTP 헤더 구성 을 참조하십시오.

- 4

- 헤더에서 수행되는 작업 유형입니다. 이 필드에는

Set또는Delete값이 있을 수 있습니다. - 5

- HTTP 헤더를 설정할 때

값을제공해야 합니다. 값은 해당 헤더에 사용 가능한 지시문 목록(예:DENY)의 문자열이거나 HAProxy의 동적 값 구문을 사용하여 해석되는 동적 값이 될 수 있습니다. 이 경우 동적 값이 추가됩니다.

참고HTTP 응답에 대한 동적 헤더 값을 설정하기 위해 허용되는 샘플 페이퍼는

res.hdr및ssl_c_der입니다. HTTP 요청에 대한 동적 헤더 값을 설정하는 경우 허용되는 샘플 페더는req.hdr및ssl_c_der입니다. request 및 response 동적 값은 모두lower및base64컨버터를 사용할 수 있습니다.- 파일을 저장하여 변경 사항을 적용합니다.

2.8.14. X-Forwarded 헤더 사용

HAProxy Ingress 컨트롤러를 구성하여 Forwarded 및 X-Forwarded-For를 포함한 HTTP 헤더 처리 방법에 대한 정책을 지정합니다. Ingress Operator는 HTTPHeaders 필드를 사용하여 Ingress 컨트롤러의 ROUTER_SET_FORWARDED_HEADERS 환경 변수를 구성합니다.

절차

Ingress 컨트롤러에 대한

HTTPHeaders필드를 구성합니다.다음 명령을 사용하여

IngressController리소스를 편집합니다.$ oc edit IngressController

spec에서HTTPHeaders정책 필드를Append,Replace,IfNone또는Never로 설정합니다.apiVersion: operator.openshift.io/v1 kind: IngressController metadata: name: default namespace: openshift-ingress-operator spec: httpHeaders: forwardedHeaderPolicy: Append

사용 사례 예

클러스터 관리자는 다음을 수행할 수 있습니다.

Ingress 컨트롤러로 전달하기 전에

X-Forwarded-For헤더를 각 요청에 삽입하는 외부 프록시를 구성합니다.헤더를 수정하지 않은 상태로 전달하도록 Ingress 컨트롤러를 구성하려면

never정책을 지정합니다. 그러면 Ingress 컨트롤러에서 헤더를 설정하지 않으며 애플리케이션은 외부 프록시에서 제공하는 헤더만 수신합니다.외부 프록시에서 외부 클러스터 요청에 설정한

X-Forwarded-For헤더를 수정하지 않은 상태로 전달하도록 Ingress 컨트롤러를 구성합니다.외부 프록시를 통과하지 않는 내부 클러스터 요청에

X-Forwarded-For헤더를 설정하도록 Ingress 컨트롤러를 구성하려면if-none정책을 지정합니다. HTTP 요청에 이미 외부 프록시를 통해 설정된 헤더가 있는 경우 Ingress 컨트롤러에서 해당 헤더를 보존합니다. 요청이 프록시를 통해 제공되지 않아 헤더가 없는 경우에는 Ingress 컨트롤러에서 헤더를 추가합니다.

애플리케이션 개발자는 다음을 수행할 수 있습니다.

X-Forwarded-For헤더를 삽입하는 애플리케이션별 외부 프록시를 구성합니다.다른 경로에 대한 정책에 영향을 주지 않으면서 애플리케이션 경로에 대한 헤더를 수정하지 않은 상태로 전달하도록 Ingress 컨트롤러를 구성하려면 애플리케이션 경로에 주석

haproxy.router.openshift.io/set-forwarded-headers: if-none또는haproxy.router.openshift.io/set-forwarded-headers: never를 추가하십시오.참고Ingress 컨트롤러에 전역적으로 설정된 값과 관계없이 경로별로

haproxy.router.openshift.io/set-forwarded-headers주석을 설정할 수 있습니다.

2.8.15. HTTP/2 수신 연결 사용

이제 HAProxy에서 투명한 엔드 투 엔드 HTTP/2 연결을 활성화할 수 있습니다. 애플리케이션 소유자는 이를 통해 단일 연결, 헤더 압축, 바이너리 스트림 등 HTTP/2 프로토콜 기능을 활용할 수 있습니다.

개별 Ingress 컨트롤러 또는 전체 클러스터에 대해 HAProxy에서 HTTP/2 연결을 활성화할 수 있습니다.

클라이언트에서 HAProxy로의 연결에 HTTP/2 사용을 활성화하려면 경로에서 사용자 정의 인증서를 지정해야 합니다. 기본 인증서를 사용하는 경로에서는 HTTP/2를 사용할 수 없습니다. 이것은 동일한 인증서를 사용하는 다른 경로의 연결을 클라이언트가 재사용하는 등 동시 연결로 인한 문제를 방지하기 위한 제한입니다.

HAProxy에서 애플리케이션 pod로의 연결은 re-encrypt 라우팅에만 HTTP/2를 사용할 수 있으며 Edge termination 또는 비보안 라우팅에는 사용할 수 없습니다. 이 제한은 백엔드와 HTTP/2 사용을 협상할 때 HAProxy가 TLS의 확장인 ALPN(Application-Level Protocol Negotiation)을 사용하기 때문에 필요합니다. 이는 엔드 투 엔드 HTTP/2가 패스스루(passthrough) 및 re-encrypt 라우팅에는 적합하지만 비보안 또는 Edge termination 라우팅에는 적합하지 않음을 의미합니다.

패스스루(passthrough)가 아닌 경로의 경우 Ingress 컨트롤러는 클라이언트와의 연결과 관계없이 애플리케이션에 대한 연결을 협상합니다. 다시 말해 클라이언트가 Ingress 컨트롤러에 연결하여 HTTP/1.1을 협상하고, Ingress 컨트롤러가 애플리케이션에 연결하여 HTTP/2를 협상하고, 클라이언트 HTTP/1.1 연결에서 받은 요청을 HTTP/2 연결을 사용하여 애플리케이션에 전달할 수 있습니다. Ingress 컨트롤러는 WebSocket을 HTTP/2로 전달할 수 없고 HTTP/2 연결을 WebSocket으로 업그레이드할 수 없기 때문에 나중에 클라이언트가 HTTP/1.1 연결을 WebSocket 프로토콜로 업그레이드하려고 하면 문제가 발생하게 됩니다. 결과적으로, WebSocket 연결을 허용하는 애플리케이션이 있는 경우 HTTP/2 프로토콜 협상을 허용하지 않아야 합니다. 그러지 않으면 클라이언트가 WebSocket 프로토콜로 업그레이드할 수 없게 됩니다.

절차

단일 Ingress 컨트롤러에서 HTTP/2를 활성화합니다.

Ingress 컨트롤러에서 HTTP/2를 사용하려면 다음과 같이

oc annotate명령을 입력합니다.$ oc -n openshift-ingress-operator annotate ingresscontrollers/<ingresscontroller_name> ingress.operator.openshift.io/default-enable-http2=true

<ingresscontroller_name>을 주석 처리할 Ingress 컨트롤러의 이름으로 변경합니다.

전체 클러스터에서 HTTP/2를 활성화합니다.

전체 클러스터에 HTTP/2를 사용하려면

oc annotate명령을 입력합니다.$ oc annotate ingresses.config/cluster ingress.operator.openshift.io/default-enable-http2=true

작은 정보다음 YAML을 적용하여 주석을 추가할 수도 있습니다.

apiVersion: config.openshift.io/v1 kind: Ingress metadata: name: cluster annotations: ingress.operator.openshift.io/default-enable-http2: "true"

2.8.16. Ingress 컨트롤러에 대한 PROXY 프로토콜 구성

클러스터 관리자는 Ingress 컨트롤러에서 HostNetwork 또는 NodePortService 엔드포인트 게시 전략 유형을 사용하는 경우 PROXY 프로토콜을 구성할 수 있습니다. PROXY 프로토콜을 사용하면 로드 밸런서에서 Ingress 컨트롤러가 수신하는 연결에 대한 원래 클라이언트 주소를 유지할 수 있습니다. 원래 클라이언트 주소는 HTTP 헤더를 로깅, 필터링 및 삽입하는 데 유용합니다. 기본 구성에서 Ingress 컨트롤러가 수신하는 연결에는 로드 밸런서와 연결된 소스 주소만 포함됩니다.

이 기능은 클라우드 배포에서 지원되지 않습니다. 이는 AWS의 Red Hat OpenShift Service가 클라우드 플랫폼에서 실행되고 IngressController가 서비스 로드 밸런서를 사용해야 함을 지정하는 경우 Ingress Operator는 로드 밸런서 서비스를 구성하고 소스 주소를 유지하기 위한 플랫폼 요구 사항에 따라 PROXY 프로토콜을 활성화하기 때문입니다.

PROXY 프로토콜을 사용하거나 TCP를 사용하려면 AWS에서 Red Hat OpenShift Service를 모두 구성하고 외부 로드 밸런서를 구성해야 합니다.

PROXY 프로토콜은 Keepalived Ingress VIP를 사용하는 클라우드 이외의 플랫폼에서 설치 관리자 프로비저닝 클러스터가 있는 기본 Ingress 컨트롤러에 지원되지 않습니다.

사전 요구 사항

- Ingress 컨트롤러가 생성되어 있습니다.

절차

Ingress 컨트롤러 리소스를 편집합니다.

$ oc -n openshift-ingress-operator edit ingresscontroller/default

PROXY 구성을 설정합니다.

Ingress 컨트롤러에서 hostNetwork 엔드포인트 게시 전략 유형을 사용하는 경우

spec.endpointPublishingStrategy.hostNetwork.protocol하위 필드를PROXY로 설정합니다.PROXY에 대한hostNetwork구성 샘플spec: endpointPublishingStrategy: hostNetwork: protocol: PROXY type: HostNetworkIngress 컨트롤러에서 NodePortService 엔드포인트 게시 전략 유형을 사용하는 경우

spec.endpointPublishingStrategy.nodePort.protocol하위 필드를PROXY로 설정합니다.PROXY에 대한nodePort구성 샘플spec: endpointPublishingStrategy: nodePort: protocol: PROXY type: NodePortService

2.8.17. appsDomain 옵션을 사용하여 대체 클러스터 도메인 지정

클러스터 관리자는 appsDomain 필드를 구성하여 사용자가 생성한 경로에 대한 기본 클러스터 도메인의 대안을 지정할 수 있습니다. appsDomain 필드는 domain 필드에 지정된 기본값 대신 사용할 AWS의 Red Hat OpenShift Service의 선택적 도메인 입니다. 대체 도메인을 지정하면 새 경로의 기본 호스트를 결정하기 위해 기본 클러스터 도메인을 덮어씁니다.

예를 들어, 회사의 DNS 도메인을 클러스터에서 실행되는 애플리케이션의 경로 및 인그레스의 기본 도메인으로 사용할 수 있습니다.

사전 요구 사항

- AWS 클러스터에 Red Hat OpenShift Service를 배포했습니다.

-

oc명령줄 인터페이스를 설치했습니다.

절차

사용자 생성 경로에 대한 대체 기본 도메인을 지정하여

appsDomain필드를 구성합니다.ingress

클러스터리소스를 편집합니다.$ oc edit ingresses.config/cluster -o yaml

YAML 파일을 편집합니다.

test.example.com에 대한appsDomain구성 샘플apiVersion: config.openshift.io/v1 kind: Ingress metadata: name: cluster spec: domain: apps.example.com 1 appsDomain: <test.example.com> 2

경로를 노출하고 경로 도메인 변경을 확인하여 기존 경로에

appsDomain필드에 지정된 도메인 이름이 포함되어 있는지 확인합니다.참고경로를 노출하기 전에

openshift-apiserver가 롤링 업데이트를 완료할 때까지 기다립니다.경로를 노출합니다.

$ oc expose service hello-openshift route.route.openshift.io/hello-openshift exposed

출력 예:

$ oc get routes NAME HOST/PORT PATH SERVICES PORT TERMINATION WILDCARD hello-openshift hello_openshift-<my_project>.test.example.com hello-openshift 8080-tcp None

2.8.18. HTTP 헤더 대소문자 변환

HAProxy 소문자 HTTP 헤더 이름(예: Host: xyz.com )을 host: xyz.com 으로 변경합니다. 기존 애플리케이션이 HTTP 헤더 이름의 대문자에 민감한 경우 Ingress Controller spec.httpHeaders.headerNameCaseAdjustments API 필드를 사용하여 기존 애플리케이션을 수정할 때 까지 지원합니다.

AWS의 Red Hat OpenShift Service에는 HAProxy 2.6이 포함되어 있으므로 업그레이드하기 전에 spec.httpHeaders.headerNameCaseAdjustments 를 사용하여 필요한 구성을 추가하십시오.

사전 요구 사항

-

OpenShift CLI(

oc)가 설치되어 있습니다. -

cluster-admin역할의 사용자로 클러스터에 액세스할 수 있어야 합니다.

프로세스

클러스터 관리자는 oc patch 명령을 입력하거나 Ingress 컨트롤러 YAML 파일에서 HeaderNameCaseAdjustments 필드를 설정하여 HTTP 헤더 케이스를 변환할 수 있습니다.

oc patch명령을 입력하여 대문자로 작성할 HTTP 헤더를 지정합니다.oc patch명령을 입력하여 HTTPhost헤더를Host로 변경합니다.$ oc -n openshift-ingress-operator patch ingresscontrollers/default --type=merge --patch='{"spec":{"httpHeaders":{"headerNameCaseAdjustments":["Host"]}}}'애플리케이션 경로에 주석을 추가합니다.

$ oc annotate routes/my-application haproxy.router.openshift.io/h1-adjust-case=true

그런 다음 Ingress 컨트롤러는 지정된 대로

host요청 헤더를 조정합니다.

Ingress 컨트롤러 YAML 파일을 구성하여

HeaderNameCaseAdjustments필드를 사용하여 조정합니다.다음 예제 Ingress 컨트롤러 YAML은 적절하게 주석이 달린 경로의 HTTP/1 요청에 대해

host헤더를Host로 조정합니다.Ingress 컨트롤러 YAML 예시

apiVersion: operator.openshift.io/v1 kind: IngressController metadata: name: default namespace: openshift-ingress-operator spec: httpHeaders: headerNameCaseAdjustments: - Host다음 예제 경로에서는

haproxy.router.openshift.io/h1-adjust-case주석을 사용하여 HTTP 응답 헤더 이름 대소문자 조정을 활성화합니다.경로 YAML의 예

apiVersion: route.openshift.io/v1 kind: Route metadata: annotations: haproxy.router.openshift.io/h1-adjust-case: true 1 name: my-application namespace: my-application spec: to: kind: Service name: my-application- 1

haproxy.router.openshift.io/h1-adjust-case를 true로 설정합니다.

2.8.19. 라우터 압축 사용

특정 MIME 유형에 대해 전역적으로 라우터 압축을 지정하도록 HAProxy Ingress 컨트롤러를 구성합니다. mimeTypes 변수를 사용하여 압축이 적용되는 MIME 유형의 형식을 정의할 수 있습니다. 유형은 application, image, message, multipart, text, video 또는 "X-"가 붙은 사용자 지정 유형입니다. MIME 유형 및 하위 유형에 대한 전체 표기법을 보려면 RFC1341 을 참조하십시오.

압축에 할당된 메모리는 최대 연결에 영향을 미칠 수 있습니다. 또한 큰 버퍼를 압축하면 많은 regex 또는 긴 regex 목록과 같은 대기 시간이 발생할 수 있습니다.

모든 MIME 유형이 압축의 이점은 아니지만 HAProxy는 여전히 리소스를 사용하여 다음을 지시한 경우 압축합니다. 일반적으로 html, css, js와 같은 텍스트 형식은 압축할 수 있지만 이미 압축한 형식(예: 이미지, 오디오, 비디오 등)은 압축에 소요되는 시간과 리소스를 거의 교환하지 못합니다.

프로세스

Ingress 컨트롤러의

httpCompression필드를 구성합니다.다음 명령을 사용하여

IngressController리소스를 편집합니다.$ oc edit -n openshift-ingress-operator ingresscontrollers/default

spec에서httpCompression정책 필드를mimeTypes로 설정하고 압축이 적용되어야 하는 MIME 유형 목록을 지정합니다.apiVersion: operator.openshift.io/v1 kind: IngressController metadata: name: default namespace: openshift-ingress-operator spec: httpCompression: mimeTypes: - "text/html" - "text/css; charset=utf-8" - "application/json" ...

2.8.20. 라우터 지표 노출

기본 통계 포트인 1936에서 Prometheus 형식으로 기본적으로 HAProxy 라우터 지표를 노출할 수 있습니다. Prometheus와 같은 외부 메트릭 컬렉션 및 집계 시스템은 HAProxy 라우터 지표에 액세스할 수 있습니다. 브라우저에서 HAProxy 라우터 메트릭을 HTML 및 쉼표로 구분된 값(CSV) 형식으로 볼 수 있습니다.

사전 요구 사항

- 기본 통계 포트인 1936에 액세스하도록 방화벽을 구성했습니다.

절차

다음 명령을 실행하여 라우터 Pod 이름을 가져옵니다.

$ oc get pods -n openshift-ingress

출력 예

NAME READY STATUS RESTARTS AGE router-default-76bfffb66c-46qwp 1/1 Running 0 11h

라우터 Pod가

/var/lib/haproxy/conf/metrics-auth/statsUsername및/var/lib/haproxy/conf/metrics-auth/statsPassword파일에 저장하는 라우터의 사용자 이름과 암호를 가져옵니다.다음 명령을 실행하여 사용자 이름을 가져옵니다.

$ oc rsh <router_pod_name> cat metrics-auth/statsUsername

다음 명령을 실행하여 암호를 가져옵니다.

$ oc rsh <router_pod_name> cat metrics-auth/statsPassword

다음 명령을 실행하여 라우터 IP 및 메트릭 인증서를 가져옵니다.

$ oc describe pod <router_pod>

다음 명령을 실행하여 Prometheus 형식으로 원시 통계를 가져옵니다.

$ curl -u <user>:<password> http://<router_IP>:<stats_port>/metrics

다음 명령을 실행하여 메트릭에 안전하게 액세스합니다.

$ curl -u user:password https://<router_IP>:<stats_port>/metrics -k

다음 명령을 실행하여 기본 stats 포트 1936에 액세스합니다.

$ curl -u <user>:<password> http://<router_IP>:<stats_port>/metrics

예 2.1. 출력 예

... # HELP haproxy_backend_connections_total Total number of connections. # TYPE haproxy_backend_connections_total gauge haproxy_backend_connections_total{backend="http",namespace="default",route="hello-route"} 0 haproxy_backend_connections_total{backend="http",namespace="default",route="hello-route-alt"} 0 haproxy_backend_connections_total{backend="http",namespace="default",route="hello-route01"} 0 ... # HELP haproxy_exporter_server_threshold Number of servers tracked and the current threshold value. # TYPE haproxy_exporter_server_threshold gauge haproxy_exporter_server_threshold{type="current"} 11 haproxy_exporter_server_threshold{type="limit"} 500 ... # HELP haproxy_frontend_bytes_in_total Current total of incoming bytes. # TYPE haproxy_frontend_bytes_in_total gauge haproxy_frontend_bytes_in_total{frontend="fe_no_sni"} 0 haproxy_frontend_bytes_in_total{frontend="fe_sni"} 0 haproxy_frontend_bytes_in_total{frontend="public"} 119070 ... # HELP haproxy_server_bytes_in_total Current total of incoming bytes. # TYPE haproxy_server_bytes_in_total gauge haproxy_server_bytes_in_total{namespace="",pod="",route="",server="fe_no_sni",service=""} 0 haproxy_server_bytes_in_total{namespace="",pod="",route="",server="fe_sni",service=""} 0 haproxy_server_bytes_in_total{namespace="default",pod="docker-registry-5-nk5fz",route="docker-registry",server="10.130.0.89:5000",service="docker-registry"} 0 haproxy_server_bytes_in_total{namespace="default",pod="hello-rc-vkjqx",route="hello-route",server="10.130.0.90:8080",service="hello-svc-1"} 0 ...브라우저에 다음 URL을 입력하여 통계 창을 시작합니다.

http://<user>:<password>@<router_IP>:<stats_port>

선택 사항: 브라우저에 다음 URL을 입력하여 CSV 형식으로 통계를 가져옵니다.

http://<user>:<password>@<router_ip>:1936/metrics;csv

2.8.21. HAProxy 오류 코드 응답 페이지 사용자 정의

클러스터 관리자는 503, 404 또는 두 오류 페이지에 대한 사용자 지정 오류 코드 응답 페이지를 지정할 수 있습니다. HAProxy 라우터는 애플리케이션 pod가 실행 중이 아닌 경우 503 오류 페이지 또는 요청된 URL이 없는 경우 404 오류 페이지를 제공합니다. 예를 들어 503 오류 코드 응답 페이지를 사용자 지정하면 애플리케이션 pod가 실행되지 않을 때 페이지가 제공되며 HAProxy 라우터에서 잘못된 경로 또는 존재하지 않는 경로에 대해 기본 404 오류 코드 HTTP 응답 페이지가 제공됩니다.

사용자 정의 오류 코드 응답 페이지가 구성 맵에 지정되고 Ingress 컨트롤러에 패치됩니다. 구성 맵 키의 사용 가능한 파일 이름은 error-page-503.http 및 error-page-404.http 입니다.

사용자 지정 HTTP 오류 코드 응답 페이지는 HAProxy HTTP 오류 페이지 구성 지침을 따라야 합니다. 다음은 AWS HAProxy 라우터 http 503 오류 코드 응답 페이지의 기본 Red Hat OpenShift Service의 예입니다. 기본 콘텐츠를 고유한 사용자 지정 페이지를 생성하기 위한 템플릿으로 사용할 수 있습니다.

기본적으로 HAProxy 라우터는 애플리케이션이 실행 중이 아니거나 경로가 올바르지 않거나 존재하지 않는 경우 503 오류 페이지만 제공합니다. 이 기본 동작은 AWS 4.8 및 이전 버전의 Red Hat OpenShift Service의 동작과 동일합니다. HTTP 오류 코드 응답 사용자 정의에 대한 구성 맵이 제공되지 않고 사용자 정의 HTTP 오류 코드 응답 페이지를 사용하는 경우 라우터는 기본 404 또는 503 오류 코드 응답 페이지를 제공합니다.

AWS의 Red Hat OpenShift Service를 기본 503 오류 코드 페이지를 사용자 지정 템플릿으로 사용하는 경우 파일의 헤더에는 CRLF 줄 끝을 사용할 수 있는 편집기가 필요합니다.

프로세스

openshift-config네임스페이스에my-custom-error-code-pages라는 구성 맵을 생성합니다.$ oc -n openshift-config create configmap my-custom-error-code-pages \ --from-file=error-page-503.http \ --from-file=error-page-404.http

중요사용자 정의 오류 코드 응답 페이지에 올바른 형식을 지정하지 않으면 라우터 Pod 중단이 발생합니다. 이 중단을 해결하려면 구성 맵을 삭제하거나 수정하고 영향을 받는 라우터 Pod를 삭제하여 올바른 정보로 다시 생성해야 합니다.

이름별로

my-custom-error-code-pages구성 맵을 참조하도록 Ingress 컨트롤러를 패치합니다.$ oc patch -n openshift-ingress-operator ingresscontroller/default --patch '{"spec":{"httpErrorCodePages":{"name":"my-custom-error-code-pages"}}}' --type=mergeIngress Operator는

my-custom-error-code-pages구성 맵을openshift-config네임스페이스에서openshift-ingress네임스페이스로 복사합니다. Operator는openshift-ingress네임스페이스에서<your_ingresscontroller_name>-errorpages패턴에 따라 구성 맵의 이름을 지정합니다.복사본을 표시합니다.

$ oc get cm default-errorpages -n openshift-ingress

출력 예

NAME DATA AGE default-errorpages 2 25s 1- 1

defaultIngress 컨트롤러 CR(사용자 정의 리소스)이 패치되었기 때문에 구성 맵 이름은default-errorpages입니다.

사용자 정의 오류 응답 페이지가 포함된 구성 맵이 라우터 볼륨에 마운트되는지 확인합니다. 여기서 구성 맵 키는 사용자 정의 HTTP 오류 코드 응답이 있는 파일 이름입니다.

503 사용자 지정 HTTP 사용자 정의 오류 코드 응답의 경우:

$ oc -n openshift-ingress rsh <router_pod> cat /var/lib/haproxy/conf/error_code_pages/error-page-503.http

404 사용자 지정 HTTP 사용자 정의 오류 코드 응답의 경우:

$ oc -n openshift-ingress rsh <router_pod> cat /var/lib/haproxy/conf/error_code_pages/error-page-404.http

검증

사용자 정의 오류 코드 HTTP 응답을 확인합니다.

테스트 프로젝트 및 애플리케이션을 생성합니다.

$ oc new-project test-ingress

$ oc new-app django-psql-example

503 사용자 정의 http 오류 코드 응답의 경우:

- 애플리케이션의 모든 pod를 중지합니다.

다음 curl 명령을 실행하거나 브라우저에서 경로 호스트 이름을 방문합니다.

$ curl -vk <route_hostname>

404 사용자 정의 http 오류 코드 응답의 경우:

- 존재하지 않는 경로 또는 잘못된 경로를 방문합니다.

다음 curl 명령을 실행하거나 브라우저에서 경로 호스트 이름을 방문합니다.

$ curl -vk <route_hostname>

errorfile속성이haproxy.config파일에 제대로 있는지 확인합니다.$ oc -n openshift-ingress rsh <router> cat /var/lib/haproxy/conf/haproxy.config | grep errorfile

2.8.22. Ingress 컨트롤러 최대 연결 설정

클러스터 관리자는 OpenShift 라우터 배포에 대한 최대 동시 연결 수를 설정할 수 있습니다. 기존 Ingress 컨트롤러를 패치하여 최대 연결 수를 늘릴 수 있습니다.

사전 요구 사항

- 다음은 Ingress 컨트롤러를 이미 생성했다고 가정합니다.

프로세스

HAProxy의 최대 연결 수를 변경하도록 Ingress 컨트롤러를 업데이트합니다.

$ oc -n openshift-ingress-operator patch ingresscontroller/default --type=merge -p '{"spec":{"tuningOptions": {"maxConnections": 7500}}}'주의spec.tuningOptions.maxConnections값을 현재 운영 체제 제한보다 크게 설정하면 HAProxy 프로세스가 시작되지 않습니다. 이 매개변수에 대한 자세한 내용은 "Ingress Controller 구성 매개변수" 섹션의 표를 참조하십시오.

2.9. Red Hat OpenShift Service on AWS Ingress Operator 구성

다음 표에서는 Ingress Operator의 구성 요소에 대해 자세히 설명하고 Red Hat 사이트 안정성 엔지니어(SRE)가 AWS 클러스터의 Red Hat OpenShift Service에서 이 구성 요소를 유지 관리하는 경우

표 2.3. Ingress Operator 책임 차트

| Ingress 구성 요소 | 관리 대상 | 기본 설정? |

|---|---|---|

| 스케일링 Ingress 컨트롤러 | SRE | 제공됨 |

| Ingress Operator 스레드 수 | SRE | 제공됨 |

| Ingress 컨트롤러 액세스 로깅 | SRE | 제공됨 |

| Ingress 컨트롤러 분할 | SRE | 제공됨 |

| Ingress 컨트롤러 경로 허용 정책 | SRE | 제공됨 |

| Ingress 컨트롤러 와일드카드 경로 | SRE | 제공됨 |

| Ingress 컨트롤러 X-Forwarded 헤더 | SRE | 제공됨 |

| Ingress 컨트롤러 경로 압축 | SRE | 제공됨 |

3장. AWS Load Balancer Operator

AWS Load Balancer Operator(ALBO)는 사용자가 선택적으로 AWS(ROSA) 클러스터의 SRE-managed Red Hat OpenShift Service에 설치할 수 있는 Red Hat에서 지원하는 Operator입니다. ALBO는 ROSA 클러스터에서 실행되는 애플리케이션에 대해 AWS Elastic Load Balancing v2(ELBv2) 서비스를 프로비저닝하는 AWS 관리형 AWS 로드 밸런서 컨트롤러(ALBC)의 라이프사이클을 관리합니다.

3.1. AWS Load Balancer Operator 설치

특정 요구 사항을 충족하는 경우 AWS Load Balancer Operator (ALBO)를 설치할 수 있습니다.

사전 요구 사항

- STS 모드에 설치된 여러 가용성 영역(AZ)에서 BYO-VPC(Bring-your-your-own-VPC) 구성이 있는 AWS(ROSA)에 기존 Red Hat OpenShift Service가 있습니다.

-

dedicated-admin역할의 사용자로 클러스터에 액세스할 수 있습니다. - 생성된 ROSA 클러스터의 VPC 및 서브넷을 수정할 수 있습니다.

-

ROSA CLI(

rosa)를 설치했습니다. - AWS(Amazon Web Services) CLI를 설치했습니다.

- OpenShift CLI(oc)가 설치되어 있습니다.

- OCP(OpenShift Container Platform) 4.13 이상을 사용하고 있습니다.

AWS Local Zone(LZ)에서 ROSA 클러스터와 함께 사용할 ALBO를 설치할 때 계정에 AWS LZ를 활성화해야 하며 AWS Elastic Load Balancing v2(ELBv2) 서비스를 AWS LZ에서 사용할 수 있어야 합니다.

절차

다음 명령을 실행하여 클러스터 인프라 ID와 클러스터 OpenID Connect(OIDC) DNS를 식별합니다.

ROSA 클러스터 INFRA ID를 식별합니다.

$ rosa describe cluster --cluster=<cluster_name> | grep -i 'Infra ID'

또는

$ oc get infrastructure cluster -o json | jq -r '.status.infrastructureName'

ROSA 클러스터 OIDC DNS를 식별합니다.

$ rosa describe cluster --cluster=<cluster_name> | grep -i 'OIDC'

명령의 출력을 저장합니다. 이 정보는 이 절차의 향후 단계에서 사용됩니다.

ALBO에 필요한 AWS IAM 정책을 생성합니다.

dedicated-admin역할의 사용자로 ROSA 클러스터에 로그인하고 다음 명령을 사용하여 새 프로젝트를 생성합니다.$ oc new-project aws-load-balancer-operator

새로 생성된 AWS IAM 역할에 다음 신뢰 정책을 할당합니다.

$ IDP='{Cluster_OIDC_Endpoint}' $ IDP_ARN="arn:aws:iam::{AWS_AccountNo}:oidc-provider/${IDP}" 1 $ cat <<EOF > albo-operator-trusted-policy.json { "Version": "2012-10-17", "Statement": [ { "Effect": "Allow", "Principal": { "Federated": "${IDP_ARN}" }, "Action": "sts:AssumeRoleWithWebIdentity", "Condition": { "StringEquals": { "${IDP}:sub": "system:serviceaccount:aws-load-balancer-operator:aws-load-balancer-operator-controller-manager" } } } ] } EOF- 1

- '{AWS_AccountNo}'를 AWS 계정 번호로 바꾸고 '{Cluster_OIDC_Endpoint}'를 이 절차의 앞부분에서 확인된 OIDC DNS로 바꿉니다.

중요{Cluster_OIDC_Endpoint}를 이전에 확인한 OIDC DNS로 교체할 때 OIDC DNS의https부분을 포함하지 마십시오. URL 내에서/를 따르는 영숫자 정보만 필요합니다.AWS IAM 역할에 신뢰 정책을 할당하는 방법에 대한 자세한 내용은 IAM 역할과 함께 신뢰 정책을 사용하는 방법을 참조하십시오.

생성된 신뢰 정책을 사용하여 역할을 생성하고 확인합니다.

$ aws iam create-role --role-name albo-operator --assume-role-policy-document file://albo-operator-trusted-policy.json $ OPERATOR_ROLE_ARN=$(aws iam get-role --role-name albo-operator --output json | jq -r '.Role.Arn') $ echo $OPERATOR_ROLE_ARN

AWS IAM 역할 생성에 대한 자세한 내용은 IAM 역할 생성 을 참조하십시오.

Operator의 권한 정책을 역할에 연결합니다.

$ curl -o albo-operator-permission-policy.json https://raw.githubusercontent.com/alebedev87/aws-load-balancer-operator/aws-cli-commands-for-sts/hack/operator-permission-policy.json aws iam put-role-policy --role-name albo-operator --policy-name perms-policy-albo-operator --policy-document file://albo-operator-permission-policy.json

AWS IAM 역할에 AWS IAM 권한을 추가하는 방법에 대한 자세한 내용은 IAM ID 권한 추가 및 제거를 참조하십시오.

Operator의 AWS 인증 정보를 생성합니다.

$ cat <<EOF> albo-operator-aws-credentials.cfg [default] sts_regional_endpoints = regional role_arn = ${OPERATOR_ROLE_ARN} web_identity_token_file = /var/run/secrets/openshift/serviceaccount/token EOF인증 정보 파일 포맷에 대한 자세한 내용은 Amazon Web Services 보안 토큰 서비스에서 수동 모드 사용을 참조하십시오.

생성된 AWS 인증 정보를 사용하여 Operator의 인증 정보 시크릿을 생성합니다.

$ oc -n aws-load-balancer-operator create secret generic aws-load-balancer-operator --from-file=credentials=albo-operator-aws-credentials.cfg

AWS Load Balancer Controller(ALBC)에 필요한 AWS IAM 정책을 생성합니다.

ID 공급자에 대한 신뢰 정책 파일을 생성합니다. 다음 예제에서는 OpenID Connect를 사용합니다.

$ IDP='{Cluster_OIDC_Endpoint}' $ IDP_ARN="arn:aws:iam::{AWS_AccountNo}:oidc-provider/${IDP}" $ cat <<EOF > albo-controller-trusted-policy.json { "Version": "2012-10-17", "Statement": [ { "Effect": "Allow", "Principal": { "Federated": "${IDP_ARN}" }, "Action": "sts:AssumeRoleWithWebIdentity", "Condition": { "StringEquals": { "${IDP}:sub": "system:serviceaccount:aws-load-balancer-operator:aws-load-balancer-controller-cluster" } } } ] } EOF생성된 신뢰 정책을 사용하여 역할을 생성하고 확인합니다.

$ aws iam create-role --role-name albo-controller --assume-role-policy-document file://albo-controller-trusted-policy.json $ CONTROLLER_ROLE_ARN=$(aws iam get-role --role-name albo-controller --output json | jq -r '.Role.Arn') $ echo $CONTROLLER_ROLE_ARN

컨트롤러의 권한 정책을 역할에 연결합니다.

$ curl -o albo-controller-permission-policy.json https://raw.githubusercontent.com/kubernetes-sigs/aws-load-balancer-controller/v2.4.7/docs/install/iam_policy.json aws iam put-role-policy --role-name albo-controller --policy-name perms-policy-albo-controller --policy-document file://albo-controller-permission-policy.json

컨트롤러의 AWS 인증 정보를 생성합니다.

$ cat <<EOF > albo-controller-aws-credentials.cfg [default] sts_regional_endpoints = regional role_arn = ${CONTROLLER_ROLE_ARN} web_identity_token_file = /var/run/secrets/openshift/serviceaccount/token EOF생성된 AWS 인증 정보를 사용하여 컨트롤러의 인증 정보 시크릿을 생성합니다.

$ oc -n aws-load-balancer-operator create secret generic aws-load-balancer-controller-cluster --from-file=credentials=albo-controller-aws-credentials.cfg

서브넷 검색에 필요한 태그를 추가합니다.

ROSA 클러스터를 호스팅하는 VPC에 다음

{Key: Value}태그를 추가합니다.{Cluster Infra ID}를 이전에 지정한 Infra ID로 바꿉니다.* kubernetes.io/cluster/${Cluster Infra ID}:owned다음 ELBv2

{Key: Value}태그를 프라이빗 서브넷에 추가하고 필요한 경우 퍼블릭 서브넷에 추가합니다.-

프라이빗 서브넷:

kubernetes.io/role/internal-elb:1 퍼블릭 서브넷:

kubernetes.io/role/elb:1참고인터넷 및 내부 로드 밸런서는 이러한 서브넷이 속한 AZ 내에 생성됩니다.

VPC 및 서브넷을 포함한 AWS 리소스에 태그를 추가하는 방법에 대한 자세한 내용은 Amazon EC2 리소스 태그를 참조하십시오.

중요ALBO에서 생성한 ELBv2 리소스(예: ALB 및 NLB)는 ROSA 클러스터에 설정된 사용자 정의 태그를 상속하지 않습니다. 이러한 리소스에 대해 태그를 별도로 설정해야 합니다.

-

프라이빗 서브넷:

ALBO를 생성합니다.

apiVersion: operators.coreos.com/v1 kind: OperatorGroup metadata: name: aws-load-balancer-operator namespace: aws-load-balancer-operator spec: upgradeStrategy: Default --- apiVersion: operators.coreos.com/v1alpha1 kind: Subscription metadata: name: aws-load-balancer-operator namespace: aws-load-balancer-operator spec: channel: stable-v1.0 installPlanApproval: Automatic name: aws-load-balancer-operator source: redhat-operators sourceNamespace: openshift-marketplace startingCSV: aws-load-balancer-operator.v1.0.0

AWS ALBC를 생성합니다.

apiVersion: networking.olm.openshift.io/v1 kind: AWSLoadBalancerController metadata: name: cluster spec: subnetTagging: Manual credentials: name: aws-load-balancer-controller-cluster중요AWS ALBCs는 AZ 및 AWS LZ와 관련된 ALB 생성을 지원하지 않으므로 ROSA 클러스터는 AWS LZ 또는 AZ와 독점적으로 연결된 ALB를 가질 수 있지만 동시에 둘 다 사용할 수 없습니다.

AWS ALBC 구성에 대한 자세한 내용은 다음 항목을 참조하십시오.

검증

다음 명령을 실행하여 설치를 확인합니다.

프로젝트 내에서 Pod에 대한 정보를 수집합니다.

$ oc get pods -n aws-load-balancer-operator

프로젝트 내에서 로그를 확인합니다.

$ oc logs -n aws-load-balancer-operator deployment/aws-load-balancer-operator-controller-manager -c manager

ROSA 클러스터에서 실행되는 애플리케이션에 대해 ELBv2가 생성되었는지 확인하는 방법에 대한 자세한 내용은 AWS Load Balancer 컨트롤러 인스턴스 생성 을 참조하십시오.

3.2. AWS Load Balancer Operator 설치 제거

AWS Load Balancer Operator(ALBO)를 설치 제거하고 관련 리소스를 전체적으로 정리하려면 다음 절차를 수행합니다.

절차

- ALBO에서 생성 및 관리하는 로드 밸런서를 삭제하여 샘플 애플리케이션을 정리합니다. 로드 밸런서를 삭제하는 방법에 대한 자세한 내용은 애플리케이션 로드 밸런서 삭제를 참조하십시오.

- 서브넷 검색 및 ALB(Application Load Balancer) 생성을 위해 서브넷에 추가된 VPC 태그를 제거하여 AWS VPC 태그를 정리합니다. 자세한 내용은 태그 기본 을 참조하십시오.

- ALBO와 Application Load Balancer Controller(ALBC)를 모두 삭제하여 ALBO 구성 요소를 정리합니다. 자세한 내용은 클러스터에서 Operator 삭제를 참조하십시오.

4장. OpenShift SDN 기본 CNI 네트워크 공급자

4.1. 프로젝트에 멀티 캐스트 사용

4.1.1. 멀티 캐스트 정보

IP 멀티 캐스트를 사용하면 데이터가 여러 IP 주소로 동시에 브로드캐스트됩니다.

- 현재 멀티 캐스트는 고 대역폭 솔루션이 아닌 저 대역폭 조정 또는 서비스 검색에 가장 적합합니다.

-

기본적으로 네트워크 정책은 네임스페이스의 모든 연결에 영향을 미칩니다. 그러나 멀티캐스트는 네트워크 정책의 영향을 받지 않습니다. 네트워크 정책과 동일한 네임스페이스에서 멀티 캐스트를 활성화하면

모든 네트워크 정책이 거부된 경우에도 항상 허용됩니다. 클러스터 관리자는 활성화하기 전에 네트워크 정책에서 멀티 캐스트에 미치는 영향을 고려해야 합니다.

AWS Pod의 Red Hat OpenShift Service 간 멀티 캐스트 트래픽은 기본적으로 비활성화되어 있습니다. OpenShift SDN 네트워크 플러그인을 사용하는 경우 프로젝트별로 멀티 캐스트를 활성화할 수 있습니다.

networkpolicy 격리 모드에서 OpenShift SDN 네트워크 플러그인을 사용하는 경우:

-

Pod에서 전송한 멀티 캐스트 패킷은

NetworkPolicy오브젝트에 관계없이 프로젝트의 다른 모든 Pod로 전달됩니다. Pod는 유니 캐스트를 통해 통신할 수 없는 경우에도 멀티 캐스트를 통해 통신할 수 있습니다. -

한 프로젝트에서 Pod가 전송한 멀티 캐스트 패킷은 프로젝트 간에 통신을 허용하는

NetworkPolicy오브젝트가 있더라도 다른 프로젝트의 Pod로 전달되지 않습니다.

다중 테넌트 격리 모드에서 OpenShift SDN 네트워크 플러그인을 사용하는 경우:

- Pod에서 전송한 멀티 캐스트 패킷은 프로젝트의 다른 모든 Pod로 전달됩니다.

- 한 프로젝트에서 Pod가 전송한 멀티 캐스트 패킷은 각 프로젝트가 함께 결합되고 각 참여 프로젝트에서 멀티 캐스트가 활성화된 경우에만 다른 프로젝트의 Pod로 전달됩니다.

4.1.2. Pod 간 멀티 캐스트 활성화

프로젝트의 Pod 간 멀티 캐스트를 활성화할 수 있습니다.

사전 요구 사항

-

OpenShift CLI(

oc)를 설치합니다. -

cluster-admin또는dedicated-admin역할이 있는 사용자로 클러스터에 로그인해야 합니다.

절차

다음 명령을 실행하여 프로젝트에 대한 멀티 캐스트를 활성화합니다. 멀티 캐스트를 활성화하려는 프로젝트의 네임스페이스로

<namespace>를 바꿉니다.$ oc annotate netnamespace <namespace> \ netnamespace.network.openshift.io/multicast-enabled=true

검증

프로젝트에 멀티 캐스트가 활성화되어 있는지 확인하려면 다음 절차를 완료합니다.

멀티 캐스트를 활성화한 프로젝트로 현재 프로젝트를 변경합니다.

<project>를 프로젝트 이름으로 바꿉니다.$ oc project <project>

멀티 캐스트 수신자 역할을 할 pod를 만듭니다.

$ cat <<EOF| oc create -f - apiVersion: v1 kind: Pod metadata: name: mlistener labels: app: multicast-verify spec: containers: - name: mlistener image: registry.access.redhat.com/ubi9 command: ["/bin/sh", "-c"] args: ["dnf -y install socat hostname && sleep inf"] ports: - containerPort: 30102 name: mlistener protocol: UDP EOF멀티 캐스트 발신자 역할을 할 pod를 만듭니다.

$ cat <<EOF| oc create -f - apiVersion: v1 kind: Pod metadata: name: msender labels: app: multicast-verify spec: containers: - name: msender image: registry.access.redhat.com/ubi9 command: ["/bin/sh", "-c"] args: ["dnf -y install socat && sleep inf"] EOF새 터미널 창 또는 탭에서 멀티 캐스트 리스너를 시작합니다.

Pod의 IP 주소를 가져옵니다.

$ POD_IP=$(oc get pods mlistener -o jsonpath='{.status.podIP}')다음 명령을 입력하여 멀티 캐스트 리스너를 시작합니다.

$ oc exec mlistener -i -t -- \ socat UDP4-RECVFROM:30102,ip-add-membership=224.1.0.1:$POD_IP,fork EXEC:hostname

멀티 캐스트 송신기를 시작합니다.

Pod 네트워크 IP 주소 범위를 가져옵니다.

$ CIDR=$(oc get Network.config.openshift.io cluster \ -o jsonpath='{.status.clusterNetwork[0].cidr}')멀티 캐스트 메시지를 보내려면 다음 명령을 입력합니다.

$ oc exec msender -i -t -- \ /bin/bash -c "echo | socat STDIO UDP4-DATAGRAM:224.1.0.1:30102,range=$CIDR,ip-multicast-ttl=64"멀티 캐스트가 작동하는 경우 이전 명령은 다음 출력을 반환합니다.

mlistener

5장. ROSA 클러스터에 대한 네트워크 확인

ROSA(Red Hat OpenShift Service on AWS) 클러스터를 기존 VPC(Virtual Private Cloud)에 배포하거나 클러스터에 새로운 서브넷이 있는 추가 머신 풀을 생성할 때 네트워크 확인 검사가 자동으로 실행됩니다. 이 검사에서는 네트워크 구성을 검증하고 오류를 강조 표시하므로 배포 전에 구성 문제를 해결할 수 있습니다.

네트워크 확인 검사를 수동으로 실행하여 기존 클러스터의 구성을 검증할 수도 있습니다.

5.1. ROSA 클러스터에 대한 네트워크 확인 이해

AWS의 ROLE(Red Hat OpenShift Service on AWS) 클러스터를 기존 VPC(Virtual Private Cloud)에 배포하거나 클러스터가 새로운 서브넷으로 추가 머신 풀을 생성하면 네트워크 확인이 자동으로 실행됩니다. 이를 통해 배포 전에 구성 문제를 식별하고 해결할 수 있습니다.

Red Hat OpenShift Cluster Manager를 사용하여 클러스터 설치를 준비하면 VPC(Virtual Private Cloud) 서브넷 설정 페이지의 서브넷 ID 필드에 서브넷 ID를 입력한 후 자동 검사가 실행됩니다. ROSA CLI(rosa)를 대화형 모드로 사용하여 클러스터를 생성하는 경우 필요한 VPC 네트워크 정보를 제공한 후 검사가 실행됩니다. 대화형 모드 없이 CLI를 사용하는 경우 클러스터 생성 직전에 검사가 시작됩니다.

서브넷이 새로 추가된 서브넷으로 머신 풀을 추가하면 자동 네트워크 확인에서 서브넷을 확인하여 머신 풀을 프로비저닝하기 전에 네트워크 연결을 사용할 수 있는지 확인합니다.

자동 네트워크 확인이 완료되면 서비스 로그에 레코드가 전송됩니다. 레코드는 네트워크 구성 오류를 포함하여 확인 확인 결과를 제공합니다. 배포 전에 확인된 문제를 해결할 수 있으며 배포의 성공 가능성이 더 높습니다.

기존 클러스터에 대해 네트워크 확인을 수동으로 실행할 수도 있습니다. 이를 통해 구성을 변경한 후 클러스터의 네트워크 구성을 확인할 수 있습니다. 네트워크 확인 검사를 수동으로 실행하는 단계는 네트워크 확인 수동 실행을 참조하십시오.

5.2. 네트워크 검증 검사 범위

네트워크 확인에는 다음 요구사항 각각에 대한 검사가 포함됩니다.

- 상위 VPC(Virtual Private Cloud)가 있습니다.

- 지정된 모든 서브넷이 VPC에 속합니다.

-

VPC에

enableDnsSupport가 활성화되어 있습니다. -

VPC에

enableDnsHostnames가 활성화되어 있습니다. - 송신은 AWS 방화벽 사전 요구 사항 섹션에 지정된 필수 도메인 및 포트 조합에서 사용할 수 있습니다.

5.3. 자동 네트워크 확인 우회

기존 VPC(Virtual Private Cloud)에 알려진 네트워크 구성 문제로 AWS(ROSA) 클러스터에 Red Hat OpenShift Service를 배포하려는 경우 자동 네트워크 확인을 바이패스할 수 있습니다.

클러스터를 생성할 때 네트워크 확인을 바이패스하면 클러스터의 지원 상태가 제한됩니다. 설치 후 문제를 해결한 다음 네트워크 확인을 수동으로 실행할 수 있습니다. 제한된 지원 상태는 검증에 성공한 후 제거됩니다.

OpenShift Cluster Manager를 사용하여 자동 네트워크 확인 우회

Red Hat OpenShift Cluster Manager를 사용하여 기존 VPC에 클러스터를 설치하는 경우 VPC(Virtual Private Cloud) 서브넷 설정 페이지에서 Bypass network verification 을 선택하여 자동 확인을 바이패스할 수 있습니다.

5.4. 수동으로 네트워크 확인 실행

ROSA(Red Hat OpenShift Service) 클러스터를 설치한 후 Red Hat OpenShift Cluster Manager 또는 ROSA CLI(rosa)를 사용하여 네트워크 확인 검사를 수동으로 실행할 수 있습니다.

OpenShift Cluster Manager를 사용하여 네트워크 확인 수동으로 실행

Red Hat OpenShift Cluster Manager를 사용하여 ROSA(Red Hat OpenShift Service on AWS) 클러스터에 대한 네트워크 확인 검사를 수동으로 실행할 수 있습니다.

사전 요구 사항

- 기존 ROSA 클러스터가 있습니다.

- 클러스터 소유자이거나 클러스터 편집기 역할이 있습니다.

절차

- OpenShift Cluster Manager 로 이동하여 클러스터를 선택합니다.

- 작업 드롭다운 메뉴에서 네트워크 확인을 선택합니다.

CLI를 사용하여 수동으로 네트워크 확인 실행

ROSA CLI(로사 )를 사용하여 ROSA(Red Hat OpenShift Service on AWS) 클러스터에 대한 네트워크 확인 검사를 수동으로 실행할 수있습니다.

네트워크 확인을 실행하면 VPC 서브넷 ID 세트 또는 클러스터 이름을 지정할 수 있습니다.

사전 요구 사항

-

설치 호스트에 최신 ROSA CLI(

rosa)를 설치하고 구성했습니다. - 기존 ROSA 클러스터가 있습니다.

- 클러스터 소유자이거나 클러스터 편집기 역할이 있습니다.

절차

다음 방법 중 하나를 사용하여 네트워크 구성을 확인합니다.

클러스터 이름을 지정하여 네트워크 구성을 확인합니다. 서브넷 ID가 자동으로 탐지됩니다.

$ rosa verify network --cluster <cluster_name> 1- 1

- &

lt;cluster_name>을 클러스터 이름으로 바꿉니다.

출력 예

I: Verifying the following subnet IDs are configured correctly: [subnet-03146b9b52b6024cb subnet-03146b9b52b2034cc] I: subnet-03146b9b52b6024cb: pending I: subnet-03146b9b52b2034cc: passed I: Run the following command to wait for verification to all subnets to complete: rosa verify network --watch --status-only --region us-east-1 --subnet-ids subnet-03146b9b52b6024cb,subnet-03146b9b52b2034cc

모든 서브넷에 대한 확인이 완료되었는지 확인합니다.

$ rosa verify network --watch \ 1 --status-only \ 2 --region <region_name> \ 3 --subnet-ids subnet-03146b9b52b6024cb,subnet-03146b9b52b2034cc 4

- 1

watch플래그는 test의 모든 서브넷이 실패 또는 전달된 상태에 있는 후 명령이 완료되도록 합니다.- 2

status-only플래그는 네트워크 확인을 트리거하지 않지만 현재 상태를 반환합니다(예:subnet-123(확인은 여전히 진행 중). 기본적으로 이 옵션이 없으면 이 명령을 호출하면 지정된 서브넷의 확인이 항상 트리거됩니다.- 3

- AWS_REGION 환경 변수를 재정의하는 특정 AWS 리전을 사용합니다.

- 4

- 쉼표로 구분된 서브넷 ID 목록을 입력하여 확인합니다. 서브넷이 없는 경우

'subnet-<subnet_number> 서브넷에 대한 Network 확인 메시지가 표시되고 서브넷을 확인하지 않습니다.

출력 예

I: Checking the status of the following subnet IDs: [subnet-03146b9b52b6024cb subnet-03146b9b52b2034cc] I: subnet-03146b9b52b6024cb: passed I: subnet-03146b9b52b2034cc: passed

작은 정보전체 확인 테스트 목록을 출력하려면

rosa verify network명령을 실행할 때--debug인수를 포함할 수 있습니다.

VPC 서브넷 ID를 지정하여 네트워크 구성을 확인합니다. <

region_name>을 AWS 리전으로 바꾸고 <AWS_account_ID>를 AWS 계정 ID로 바꿉니다.$ rosa verify network --subnet-ids 03146b9b52b6024cb,subnet-03146b9b52b2034cc --region <region_name> --role-arn arn:aws:iam::<AWS_account_ID>:role/my-Installer-Role

출력 예

I: Verifying the following subnet IDs are configured correctly: [subnet-03146b9b52b6024cb subnet-03146b9b52b2034cc] I: subnet-03146b9b52b6024cb: pending I: subnet-03146b9b52b2034cc: passed I: Run the following command to wait for verification to all subnets to complete: rosa verify network --watch --status-only --region us-east-1 --subnet-ids subnet-03146b9b52b6024cb,subnet-03146b9b52b2034cc

모든 서브넷에 대한 확인이 완료되었는지 확인합니다.

$ rosa verify network --watch --status-only --region us-east-1 --subnet-ids subnet-03146b9b52b6024cb,subnet-03146b9b52b2034cc

출력 예

I: Checking the status of the following subnet IDs: [subnet-03146b9b52b6024cb subnet-03146b9b52b2034cc] I: subnet-03146b9b52b6024cb: passed I: subnet-03146b9b52b2034cc: passed

6장. 클러스터 전체 프록시 구성

기존 VPC(Virtual Private Cloud)를 사용하는 경우, AWS(ROSA) 클러스터 설치 또는 클러스터 설치 후 Red Hat OpenShift Service on AWS에서 클러스터 전체 프록시를 구성할 수 있습니다. 프록시를 활성화하면 코어 클러스터 구성 요소가 인터넷에 대한 직접 액세스가 거부되지만 프록시는 사용자 워크로드에 영향을 미치지 않습니다.

클라우드 공급자 API에 대한 호출을 포함하여 시스템 송신 트래픽만 프록시됩니다.

클러스터 전체 프록시를 사용하는 경우 클러스터에 대한 프록시의 가용성을 유지 관리해야 합니다. 프록시를 사용할 수 없게 되면 클러스터의 상태 및 지원 가능성에 영향을 미칠 수 있습니다.

6.1. 클러스터 전체 프록시 구성을 위한 사전 요구 사항

클러스터 전체 프록시를 구성하려면 다음 요구 사항을 충족해야 합니다. 이러한 요구 사항은 설치 중 또는 설치 후 프록시를 구성할 때 유효합니다.

일반 요구 사항

- 클러스터 소유자입니다.

- 계정에는 충분한 권한이 있습니다.

- 클러스터의 기존 VPC(Virtual Private Cloud)가 있습니다.

- 프록시는 클러스터의 VPC 및 VPC의 프라이빗 서브넷에 액세스할 수 있습니다. 이 프록시는 클러스터의 VPC 및 VPC의 프라이빗 서브넷에서도 액세스할 수 있습니다.

VPC 끝점에 다음 끝점을 추가했습니다.

-

ec2.<aws_region>.amazonaws.com -

elasticloadbalancing.<aws_region>.amazonaws.com s3.<aws_region>.amazonaws.com이러한 끝점은 노드에서 AWS EC2 API로 요청을 완료하는 데 필요합니다. 프록시는 노드 수준이 아닌 컨테이너 수준에서 작동하기 때문에 이러한 요청을 AWS 사설 네트워크를 통해 AWS EC2 API로 라우팅해야 합니다. 프록시 서버의 허용 목록에 EC2 API의 공용 IP 주소를 추가하는 것만으로는 충분하지 않습니다.

참고클러스터 전체 프록시를 사용하는 경우

게이트웨이유형으로s3.<aws_region>.amazonaws.com끝점을 구성해야 합니다. 또한ec2.<aws_region>.amazonaws.com 및끝점을 유형 인터페이스로 구성할 수 있습니다.elasticloadbalancing.<aws_region>.amazonaws.com

-

네트워크 요구 사항

프록시에서 송신 트래픽을 다시 암호화하는 경우 도메인 및 포트 조합에 대한 제외를 생성해야 합니다. 다음 표에서는 이러한 예외에 대한 지침을 제공합니다.

프록시는 다음 OpenShift URL을 다시 암호화하도록 제외해야 합니다.

address 프로토콜/포트 함수 observatorium-mst.api.openshift.comhttps/443

필수 항목입니다. Managed OpenShift별 Telemetry에 사용됩니다.

sso.redhat.comhttps/443

https://cloud.redhat.com/openshift 사이트에서는 sso.redhat.com의 인증을 사용하여 클러스터 풀 시크릿을 다운로드하고 Red Hat SaaS 솔루션을 사용하여 서브스크립션, 클러스터 인벤토리 및 관련 보고를 원활하게 모니터링할 수 있습니다.

프록시는 다음 사이트 안정성 엔지니어링(SRE) 및 관리 URL을 재암호화해야 합니다.

address 프로토콜/포트 함수 *.osdsecuritylogs.splunkcloud.com또는

inputs1.osdsecuritylogs..osdsecuritylogs.complunkcloud.comsplunkcloud.cominputs2inputs4.osdsecuritylogs.splunkcloud.cominputs5.osdsecuritylogs.splunkcloud.cominputs6.osdsecuritylogs.splunkcloud.com.osdsecuritylogs.splunkcloud.comcomputes.cloudoscomstoredcloud-complunks.com computesfcloudoscomcomputecomfcloudos의 입력tcp/9997

splunk-forwarder-operator에서 로그 기반 경고에 사용할 로그 전달 끝점으로 사용합니다.

http-inputs-osdsecuritylogs.splunkcloud.comhttps/443

splunk-forwarder-operator에서 로그 기반 경고에 사용할 로그 전달 끝점으로 사용합니다.

중요프록시 서버를 사용하여 TLS 재암호화를 수행하는 것은 현재 서버가

--http-proxy또는--https-proxy인수를 통해 클러스터에서 구성되지 않은 투명한 전달 프록시 역할을 하는 경우 지원되지 않습니다.투명 전달 프록시는 클러스터 트래픽을 가로채지만 실제로 클러스터 자체에 구성되지는 않습니다.

추가 리소스

- STS(AWS Security Token Service)를 사용하는 ROSA 클러스터의 설치 사전 요구 사항은 STS를 사용한 ROSA의 AWS 사전 요구 사항을 참조하십시오.

- STS를 사용하지 않는 ROSA 클러스터에 대한 설치 사전 요구 사항은 ROSA의 AWS 사전 요구 사항을 참조하십시오.

6.2. 추가 신뢰 번들에 대한 책임

추가 신뢰 번들을 제공하는 경우 다음 요구 사항을 담당합니다.

- 추가 신뢰 번들의 콘텐츠가 유효한지 확인

- 추가 신뢰 번들에 포함된 중간 인증서를 포함하여 인증서가 만료되지 않았는지 확인

- 만료 추적 및 추가 신뢰 번들에 포함된 인증서에 필요한 갱신 수행

- 업데이트된 추가 신뢰 번들로 클러스터 구성 업데이트

6.3. 설치 중 프록시 구성

기존 VPC(Virtual Private Cloud)에 ROSA(Red Hat OpenShift Service) 클러스터를 설치할 때 HTTP 또는 HTTPS 프록시를 구성할 수 있습니다. Red Hat OpenShift Cluster Manager 또는 ROSA CLI(로사)를 사용하여 설치 중에 프록시를 구성할 수있습니다.

6.3.1. OpenShift Cluster Manager를 사용하여 설치 중에 프록시 구성

ROSA(Virtual Private Cloud) 클러스터를 기존 VPC(Virtual Private Cloud)에 설치하는 경우 Red Hat OpenShift Cluster Manager를 사용하여 설치 중에 클러스터 전체 HTTP 또는 HTTPS 프록시를 활성화할 수 있습니다.

설치하기 전에 클러스터를 설치하는 VPC에서 프록시에 액세스할 수 있는지 확인해야 합니다. VPC의 프라이빗 서브넷에서도 프록시에 액세스할 수 있어야 합니다.

OpenShift Cluster Manager를 사용하여 설치 중에 클러스터 전체 프록시를 구성하는 방법에 대한 자세한 단계는 OpenShift Cluster Manager 를 사용하여 사용자 지정으로 클러스터 생성을 참조하십시오.

6.3.2. CLI를 사용하여 설치 중에 프록시 구성

AWS(ROSA) 클러스터를 기존 VPC(Virtual Private Cloud)에 설치하는 경우 ROSA CLI(rosa)를 사용하여 설치 중에 클러스터 전체 HTTP 또는 HTTPS 프록시를 활성화할 수 있습니다.

다음 절차에서는 설치 중에 클러스터 전체 프록시를 구성하는 데 사용되는 ROSA CLI(rosa) 인수에 대한 세부 정보를 제공합니다. ROSA CLI를 사용하는 일반적인 설치 단계는 CLI를 사용하여 사용자 지정으로 클러스터 생성을 참조하십시오.

사전 요구 사항

- 클러스터가 설치되고 있는 VPC에서 프록시에 액세스할 수 있는지 확인했습니다. VPC의 프라이빗 서브넷에서도 프록시에 액세스할 수 있어야 합니다.

절차

클러스터를 생성할 때 프록시 구성을 지정합니다.

$ rosa create cluster \ <other_arguments_here> \ --additional-trust-bundle-file <path_to_ca_bundle_file> \ 1 2 3 --http-proxy http://<username>:<password>@<ip>:<port> \ 4 5 --https-proxy https://<username>:<password>@<ip>:<port> \ 6 7 --no-proxy example.com 8

- 1 4 6

additional-trust-bundle-file,http-proxy,https-proxy인수는 모두 선택 사항입니다.- 2

http-proxy또는https-proxy인수 없이additional-trust-bundle-file인수를 사용하면 신뢰 저장소에 신뢰 번들이 추가되고 클러스터 시스템 송신 트래픽을 확인하는 데 사용됩니다. 이 시나리오에서는 프록시와 함께 사용할 번들이 구성되지 않았습니다.- 3

additional-trust-bundle-file인수는 모두 서로 연결된 PEM 인코딩 X.509 인증서 번들을 가리키는 파일 경로입니다.additionalTrustBundle매개변수는 RHCOS 신뢰 번들의 기관에서 프록시의 ID 인증서를 서명하지 않는 한 필요합니다. 추가 프록시 구성은 필요하지 않아도 추가 CA는 필요한 MITM 투명 프록시 네트워크를 사용한다면 MITM CA 인증서를 제공해야 합니다.- 5 7

http-proxy및https-proxy인수는 유효한 URL을 가리켜야 합니다.- 8

- 프록시를 제외할 대상 도메인 이름, IP 주소 또는 네트워크 CIDR의 쉼표로 구분된 목록입니다.

하위 도메인과 일치하려면 도메인 앞에

.을 입력합니다. 예를 들어,.y.com은x.y.com과 일치하지만y.com은 일치하지 않습니다.*를 사용하여 모든 대상에 대해 프록시를 바이패스합니다.networking.machineNetwork[].cidr필드에 의해 정의된 네트워크에 포함되어 있지 않은 작업자를 설치 구성에서 확장하려면 연결 문제를 방지하기 위해 이 목록에 해당 작업자를 추가해야 합니다.httpProxy와httpsProxy필드가 모두 설정되지 않은 경우 이 필드는 무시됩니다.

6.4. 설치 후 프록시 구성

기존 VPC(Virtual Private Cloud)에 ROSA(Red Hat OpenShift Service) 클러스터를 설치한 후 HTTP 또는 HTTPS 프록시를 구성할 수 있습니다. Red Hat OpenShift Cluster Manager 또는 ROSA CLI(rosa)를 사용하여 설치 후 프록시를 구성할 수 있습니다.

6.4.1. OpenShift Cluster Manager를 사용하여 설치 후 프록시 구성

Red Hat OpenShift Cluster Manager를 사용하여 VPC(Virtual Private Cloud)의 AWS 클러스터의 기존 Red Hat OpenShift Service에 클러스터 전체 프록시 구성을 추가할 수 있습니다.

OpenShift Cluster Manager를 사용하여 기존 클러스터 전체 프록시 구성을 업데이트할 수도 있습니다. 예를 들어 프록시의 인증 기관이 만료되면 프록시의 네트워크 주소를 업데이트하거나 추가 신뢰 번들을 교체해야 할 수 있습니다.

클러스터는 컨트롤 플레인 및 컴퓨팅 노드에 프록시 설정을 적용합니다. 구성을 적용하는 동안 각 클러스터 노드는 일시적으로 스케줄링할 수 없는 상태로 배치되어 워크로드를 드레인합니다. 각 노드는 프로세스의 일부로 재시작됩니다.

사전 요구 사항

- AWS 클러스터에 Red Hat OpenShift Service가 있어야 합니다.

- 클러스터는 VPC에 배포되어 있습니다.

절차

- OpenShift Cluster Manager 로 이동하여 클러스터를 선택합니다.

- 네트워킹 페이지의 VPC(Virtual Private Cloud) 섹션에서 Edit cluster-wide proxy 를 클릭합니다.

클러스터 전체 프록시 편집 페이지에서 프록시 구성 세부 정보를 입력합니다.

다음 필드 중 하나 이상에 값을 입력합니다.

- 유효한 HTTP 프록시 URL 을 지정합니다.

- 유효한 HTTPS 프록시 URL 을 지정합니다.

추가 신뢰 번들 필드에서 PEM 인코딩 X.509 인증서 번들을 제공합니다. 기존 신뢰 번들 파일을 교체하는 경우 파일 교체를 선택하여 필드를 확인합니다. 번들은 클러스터 노드의 신뢰할 수 있는 인증서 저장소에 추가됩니다. 프록시의 ID 인증서가 RHCOS(Red Hat Enterprise Linux CoreOS) 신뢰 번들의 기관에서 서명하지 않는 한 추가 신뢰 번들 파일이 필요합니다.

추가 프록시 구성은 필요하지 않아도 추가 인증 기관(CA)이 필요한 MITM 투명 프록시 네트워크를 사용하는 경우 MITM CA 인증서를 제공해야 합니다.

참고HTTP 또는 HTTPS 프록시 URL을 지정하지 않고 추가 신뢰 번들 파일을 업로드하는 경우 해당 번들은 클러스터에 설정되지만 프록시와 함께 사용하도록 구성되지 않습니다.

- Confirm 을 클릭합니다.

검증

- 네트워킹 페이지의 VPC(Virtual Private Cloud) 섹션에서 클러스터의 프록시 구성이 예상대로 구성되어 있는지 확인합니다.

6.4.2. CLI를 사용하여 설치 후 프록시 구성

Red Hat OpenShift Service on AWS(ROSA) CLI(rosa)를 사용하여 VPC(Virtual Private Cloud)의 기존 ROSA 클러스터에 클러스터 전체 프록시 구성을 추가할 수 있습니다.

rosa 를 사용하여 기존 클러스터 전체 프록시 구성을 업데이트할 수도 있습니다. 예를 들어 프록시의 인증 기관이 만료되면 프록시의 네트워크 주소를 업데이트하거나 추가 신뢰 번들을 교체해야 할 수 있습니다.

클러스터는 컨트롤 플레인 및 컴퓨팅 노드에 프록시 설정을 적용합니다. 구성을 적용하는 동안 각 클러스터 노드는 일시적으로 스케줄링할 수 없는 상태로 배치되어 워크로드를 드레인합니다. 각 노드는 프로세스의 일부로 재시작됩니다.

사전 요구 사항

-

설치 호스트에 최신 ROSA(

rosa) 및 OpenShift(oc) CLI를 설치하고 구성했습니다. - VPC에 배포된 ROSA 클러스터가 있습니다.

절차

클러스터 구성을 편집하여 클러스터 전체 프록시 세부 정보를 추가하거나 업데이트합니다.

$ rosa edit cluster \ --cluster $CLUSTER_NAME \ --additional-trust-bundle-file <path_to_ca_bundle_file> \ 1 2 3 --http-proxy http://<username>:<password>@<ip>:<port> \ 4 5 --https-proxy https://<username>:<password>@<ip>:<port> \ 6 7 --no-proxy example.com 8

- 1 4 6

additional-trust-bundle-file,http-proxy,https-proxy인수는 모두 선택 사항입니다.- 2

http-proxy또는https-proxy인수 없이additional-trust-bundle-file인수를 사용하면 신뢰 저장소에 신뢰 번들이 추가되고 클러스터 시스템 송신 트래픽을 확인하는 데 사용됩니다. 이 시나리오에서는 프록시와 함께 사용할 번들이 구성되지 않았습니다.- 3

additional-trust-bundle-file인수는 모두 서로 연결된 PEM 인코딩 X.509 인증서 번들을 가리키는 파일 경로입니다.additionalTrustBundle매개변수는 RHCOS 신뢰 번들의 기관에서 프록시의 ID 인증서를 서명하지 않는 한 필요합니다. 추가 프록시 구성은 필요하지 않아도 추가 CA는 필요한 MITM 투명 프록시 네트워크를 사용한다면 MITM CA 인증서를 제공해야 합니다.참고클러스터에서 프록시 또는 추가 신뢰 번들 구성을 직접 변경하지 않아야 합니다. 이러한 변경 사항은 ROSA CLI(

rosa) 또는 Red Hat OpenShift Cluster Manager를 사용하여 적용해야 합니다. 클러스터에 직접 변경한 모든 변경 사항은 자동으로 취소됩니다.- 5 7

http-proxy및https-proxy인수는 유효한 URL을 가리켜야 합니다.- 8

- 프록시를 제외할 대상 도메인 이름, IP 주소 또는 네트워크 CIDR의 쉼표로 구분된 목록입니다.

하위 도메인과 일치하려면 도메인 앞에

.을 입력합니다. 예를 들어,.y.com은x.y.com과 일치하지만y.com은 일치하지 않습니다.*를 사용하여 모든 대상에 대해 프록시를 바이패스합니다.networking.machineNetwork[].cidr필드에 의해 정의된 네트워크에 포함되어 있지 않은 작업자를 설치 구성에서 확장하려면 연결 문제를 방지하기 위해 이 목록에 해당 작업자를 추가해야 합니다.httpProxy와httpsProxy필드가 모두 설정되지 않은 경우 이 필드는 무시됩니다.

검증

머신 구성 풀의 상태를 나열하고 업데이트가 업데이트되었는지 확인합니다.

$ oc get machineconfigpools

출력 예

NAME CONFIG UPDATED UPDATING DEGRADED MACHINECOUNT READYMACHINECOUNT UPDATEDMACHINECOUNT DEGRADEDMACHINECOUNT AGE master rendered-master-d9a03f612a432095dcde6dcf44597d90 True False False 3 3 3 0 31h worker rendered-worker-f6827a4efe21e155c25c21b43c46f65e True False False 6 6 6 0 31h

클러스터의 프록시 구성을 표시하고 세부 정보가 예상대로 표시되는지 확인합니다.

$ oc get proxy cluster -o yaml

출력 예

apiVersion: config.openshift.io/v1 kind: Proxy spec: httpProxy: http://proxy.host.domain:<port> httpsProxy: https://proxy.host.domain:<port> <...more...> status: httpProxy: http://proxy.host.domain:<port> httpsProxy: https://proxy.host.domain:<port> <...more...>

6.5. 클러스터 전체 프록시 제거

ROSA CLI를 사용하여 클러스터 전체 프록시를 제거할 수 있습니다. 클러스터를 제거한 후 클러스터에 추가된 신뢰 번들도 제거해야 합니다.

6.5.1. CLI를 사용하여 클러스터 전체 프록시 제거

클러스터에서 프록시 주소를 제거하려면 AWS(ROSA) CLI( ROSA ) CLI를 사용하여 프록시 주소를 제거해야 합니다.

사전 요구 사항

- 클러스터 관리자 권한이 있어야합니다.

-

ROSA CLI(

rosa)를 설치했습니다.

절차

프록시를 수정하려면

rosa edit명령을 사용합니다. 클러스터에서 프록시를 지우려면 빈 문자열을--http-proxy및--https-proxy인수에 전달해야 합니다.$ rosa edit cluster -c <cluster_name> --http-proxy "" --https-proxy ""

참고프록시 인수 중 하나만 사용할 수 있지만 빈 필드는 무시되므로

--http-proxy및--https-proxy인수 모두에 빈 문자열을 전달해도 문제가 발생하지 않습니다.출력 예

I: Updated cluster <cluster_name>

검증

rosa describe명령을 사용하여 클러스터에서 프록시가 제거되었는지 확인할 수 있습니다.$ rosa describe cluster -c <cluster_name>

제거하기 전에 프록시 IP가 프록시 섹션에 표시됩니다.

Name: <cluster_name> ID: <cluster_internal_id> External ID: <cluster_external_id> OpenShift Version: 4.0 Channel Group: stable DNS: <dns> AWS Account: <aws_account_id> API URL: <api_url> Console URL: <console_url> Region: us-east-1 Multi-AZ: false Nodes: - Control plane: 3 - Infra: 2 - Compute: 2 Network: - Type: OVNKubernetes - Service CIDR: <service_cidr> - Machine CIDR: <machine_cidr> - Pod CIDR: <pod_cidr> - Host Prefix: <host_prefix> Proxy: - HTTPProxy: <proxy_url> Additional trust bundle: REDACTED

프록시를 제거하면 프록시 섹션이 제거됩니다.

Name: <cluster_name> ID: <cluster_internal_id> External ID: <cluster_external_id> OpenShift Version: 4.0 Channel Group: stable DNS: <dns> AWS Account: <aws_account_id> API URL: <api_url> Console URL: <console_url> Region: us-east-1 Multi-AZ: false Nodes: - Control plane: 3 - Infra: 2 - Compute: 2 Network: - Type: OVNKubernetes - Service CIDR: <service_cidr> - Machine CIDR: <machine_cidr> - Pod CIDR: <pod_cidr> - Host Prefix: <host_prefix> Additional trust bundle: REDACTED

6.5.2. AWS 클러스터의 Red Hat OpenShift Service에서 인증 기관 제거

ROSA(Red Hat OpenShift Service on AWS) CLI, rosa 를 사용하여 클러스터에서 CA(인증 기관)를 제거할 수 있습니다.

사전 요구 사항

- 클러스터 관리자 권한이 있어야합니다.

-

ROSA CLI(

rosa)를 설치했습니다. - 클러스터에 인증 기관이 추가되었습니다.

절차

rosa edit명령을 사용하여 CA 신뢰 번들을 수정합니다. 클러스터에서 신뢰 번들을 지우려면 빈 문자열을--additional-trust-bundle-file인수로 전달해야 합니다.$ rosa edit cluster -c <cluster_name> --additional-trust-bundle-file ""

출력 예

I: Updated cluster <cluster_name>

검증

rosa describe명령을 사용하여 신뢰 번들이 클러스터에서 제거되었는지 확인할 수 있습니다.$ rosa describe cluster -c <cluster_name>

제거하기 전에 보안 목적으로 해당 값을 수정하고 추가 신뢰 번들 섹션이 표시됩니다.

Name: <cluster_name> ID: <cluster_internal_id> External ID: <cluster_external_id> OpenShift Version: 4.0 Channel Group: stable DNS: <dns> AWS Account: <aws_account_id> API URL: <api_url> Console URL: <console_url> Region: us-east-1 Multi-AZ: false Nodes: - Control plane: 3 - Infra: 2 - Compute: 2 Network: - Type: OVNKubernetes - Service CIDR: <service_cidr> - Machine CIDR: <machine_cidr> - Pod CIDR: <pod_cidr> - Host Prefix: <host_prefix> Proxy: - HTTPProxy: <proxy_url> Additional trust bundle: REDACTED

프록시를 제거하면 추가 신뢰 번들 섹션이 제거됩니다.

Name: <cluster_name> ID: <cluster_internal_id> External ID: <cluster_external_id> OpenShift Version: 4.0 Channel Group: stable DNS: <dns> AWS Account: <aws_account_id> API URL: <api_url> Console URL: <console_url> Region: us-east-1 Multi-AZ: false Nodes: - Control plane: 3 - Infra: 2 - Compute: 2 Network: - Type: OVNKubernetes - Service CIDR: <service_cidr> - Machine CIDR: <machine_cidr> - Pod CIDR: <pod_cidr> - Host Prefix: <host_prefix> Proxy: - HTTPProxy: <proxy_url>

7장. CIDR 범위 정의

다음 CIDR 범위에 대해 겹치지 않는 범위를 지정해야 합니다.

머신 CIDR 범위는 클러스터를 생성한 후에는 변경할 수 없습니다.

서브넷 CIDR 범위를 지정할 때 서브넷 CIDR 범위가 정의된 Machine CIDR 내에 있는지 확인합니다. 서브넷 CIDR 범위가 가능한 AWS Load Balancer를 위해 8개 이상의 IP 주소를 포함하여 모든 의도된 워크로드에 충분한 IP 주소를 허용하는지 확인해야 합니다.

AWS 4.11 이상에서 Red Hat OpenShift Service의 기본 네트워크 공급자인 OVN-Kubernetes는 내부적으로 100.64.0.0/16 IP 주소 범위를 사용합니다. 클러스터에서 OVN-Kubernetes를 사용하는 경우 클러스터의 다른 CIDR 정의에 100.64.0.0/16 IP 주소 범위를 포함하지 마십시오.

7.1. Machine CIDR

머신 CIDR 필드에서 시스템 또는 클러스터 노드의 IP 주소 범위를 지정해야 합니다. 이 범위는 VPC(가상 프라이빗 클라우드) 서브넷에 대한 모든 CIDR 주소 범위를 포함해야 합니다. 서브넷이 연속되어야 합니다. 단일 가용성 영역 배포에 대해 서브넷 접두사 /25 를 사용하는 최소 128 주소 범위가 지원됩니다. 여러 가용 영역을 사용하는 배포에는 서브넷 접두사 /24 를 사용하는 최소 주소 범위 256 주소가 지원됩니다.

기본값은 10.0.0.0/16 입니다. 이 범위는 연결된 네트워크와 충돌해서는 안 됩니다.

ROSA를 HCP와 함께 사용하면 고정 IP 주소 172.20.0.1 이 내부 Kubernetes API 주소용으로 예약되어 있습니다. 시스템, Pod 및 서비스 CIDR 범위가 이 IP 주소와 충돌해서는 안 됩니다.

7.2. Service CIDR

Service CIDR 필드에서 서비스의 IP 주소 범위를 지정해야 합니다. 클러스터 간에 주소 블록이 동일하지만 필수는 아닙니다. 이는 IP 주소 충돌을 생성하지 않습니다. 범위는 워크로드를 수용할 수 있을 만큼 충분히 커야 합니다. address 블록은 클러스터 내에서 액세스한 외부 서비스와 겹치지 않아야 합니다. 기본값은 172.30.0.0/16입니다.

7.3. Pod CIDR

Pod CIDR 필드에서 Pod의 IP 주소 범위를 지정해야 합니다.

클러스터 간에 주소 블록이 동일하지만 필수는 아닙니다. 이는 IP 주소 충돌을 생성하지 않습니다. 범위는 워크로드를 수용할 수 있을 만큼 충분히 커야 합니다. address 블록은 클러스터 내에서 액세스한 외부 서비스와 겹치지 않아야 합니다. 기본값은 10.128.0.0/14 입니다.

7.4. 호스트 접두사

Host Prefix 필드에서 개별 머신에 예약된 Pod에 할당된 서브넷 접두사 길이를 지정해야 합니다. 호스트 접두사는 각 머신의 Pod IP 주소 풀을 결정합니다.

예를 들어 호스트 접두사를 /23 으로 설정하면 Pod CIDR 주소 범위의 /23 서브넷이 각 시스템에 할당됩니다. 기본값은 /23 입니다. 이로 인해 512개의 클러스터 노드와 노드당 512개의 포드가 허용됩니다(두 가지 모두 최대 지원 범위를 초과함).

8장. 네트워크 정책

8.1. 네트워크 정책 정의

클러스터 관리자는 클러스터의 pod로 트래픽을 제한하는 네트워크 정책을 정의할 수 있습니다.

8.1.1. 네트워크 정책 정의

Kubernetes 네트워크 정책을 지원하는 네트워크 플러그인을 사용하는 클러스터에서 네트워크 격리는 NetworkPolicy 오브젝트에 의해 완전히 제어됩니다. AWS 4의 Red Hat OpenShift Service에서 OpenShift SDN은 기본 네트워크 격리 모드에서 네트워크 정책 사용을 지원합니다.