Red Hat OpenShift Data Science 시작하기

OpenShift Data Science 환경에서 작업하는 방법에 대해 알아보십시오.

초록

1장. OpenShift 데이터 과학에 로그인

Jupyter 및 데이터 과학 프로젝트에 쉽게 액세스할 수 있도록 브라우저에서 OpenShift 데이터 과학에 로그인합니다.

절차

OpenShift Data Science 인스턴스 URL로 이동하여 OpenShift를 사용하여 로그인을 클릭합니다.

-

사용자가 데이터 소스 사용자인 경우 관리자는 OpenShift Data Science 인스턴스 URL(예: https://rhods-dashboard-redhat-ods-applications.apps.example.abc1.p1.openshiftapps.com/)을 제공해야 합니다

. -

OpenShift Dedicated에 액세스할 수 있는 경우 OpenShift Dedicated 웹 콘솔로 이동하여 애플리케이션 시작 관리자 (

) → Red Hat OpenShift Data Science 를 클릭합니다.

) → Red Hat OpenShift Data Science 를 클릭합니다.

-

사용자가 데이터 소스 사용자인 경우 관리자는 OpenShift Data Science 인스턴스 URL(예: https://rhods-dashboard-redhat-ods-applications.apps.example.abc1.p1.openshiftapps.com/)을 제공해야 합니다

-

ID 공급자의 이름을 클릭합니다(예:

GitHub). - 자격 증명을 입력하고 Log in (또는 ID 공급자와 동등한)을 클릭합니다.

검증

- OpenShift 데이터 과학이 활성화된 애플리케이션 페이지에서 열립니다.

문제 해결

인증 오류가표시되거나 로그인할 때사용자를 만들 수 없는경우:- 인증 정보를 잘못 입력했을 수 있습니다. 인증 정보가 올바른지 확인합니다.

- 하나 이상의 구성된 ID 공급자에 계정이 있을 수 있습니다. 이전에 다른 ID 공급자로 로그인한 경우 해당 ID 공급자를 다시 시도하십시오.

추가 리소스

2장. OpenShift Data Science 사용자 인터페이스

Red Hat OpenShift Data Science 인터페이스는 OpenShift 웹 콘솔 사용자 인터페이스를 기반으로 합니다.

Red Hat OpenShift Data Science 사용자 인터페이스는 다음과 같은 여러 영역으로 나뉩니다.

도움말 및 알림 과 같은 유용한 컨트롤에 대한 액세스를 제공하는 글로벌 탐색 모음입니다.

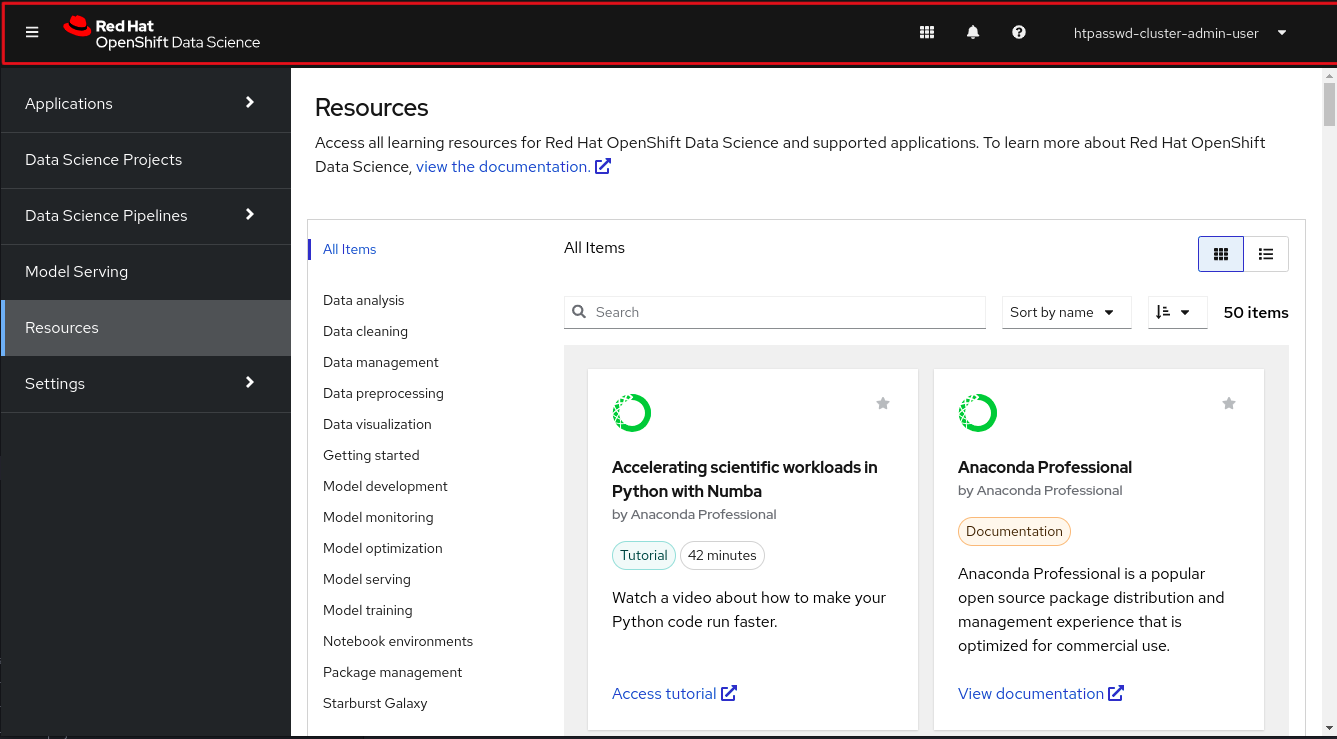

그림 2.1. 글로벌 탐색 모음

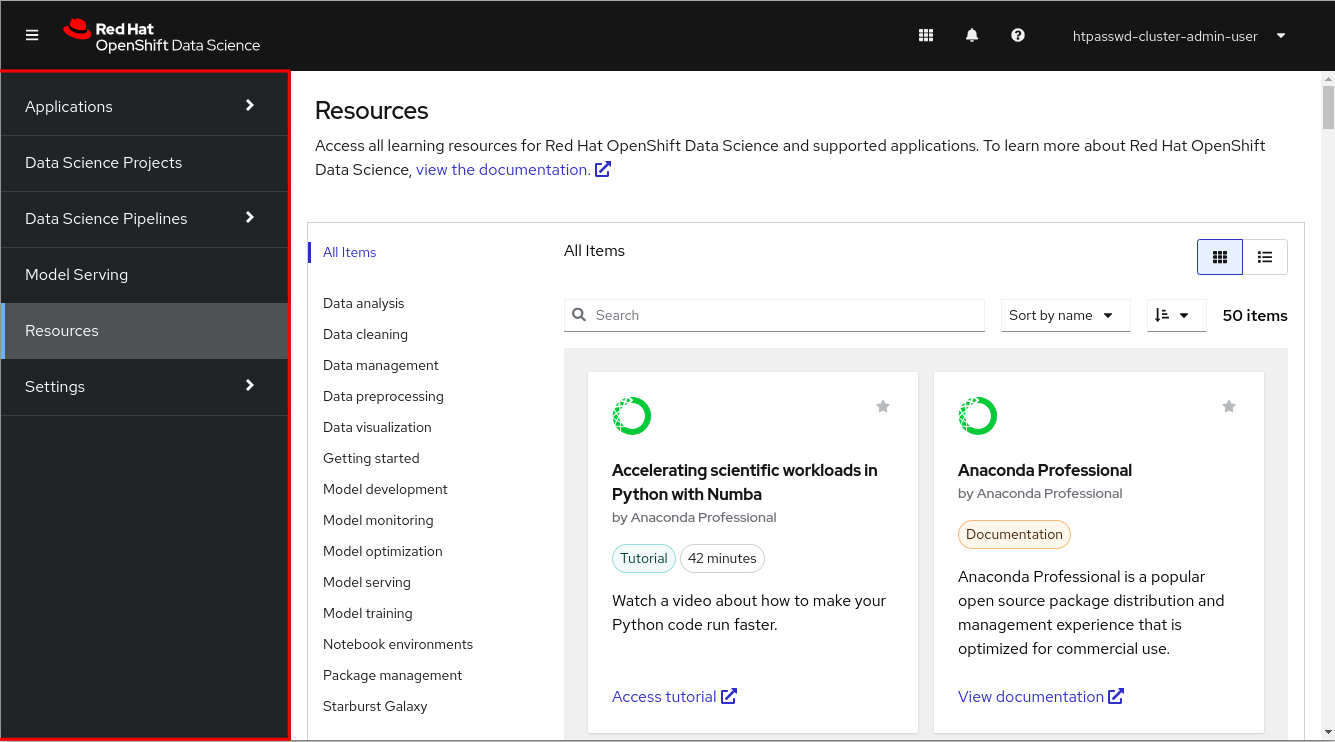

사이드 탐색 메뉴(OpenShift Dataology)에서 사용할 수 있는 다양한 카테고리가 포함되어 있습니다.

그림 2.2. 사이드 탐색 메뉴

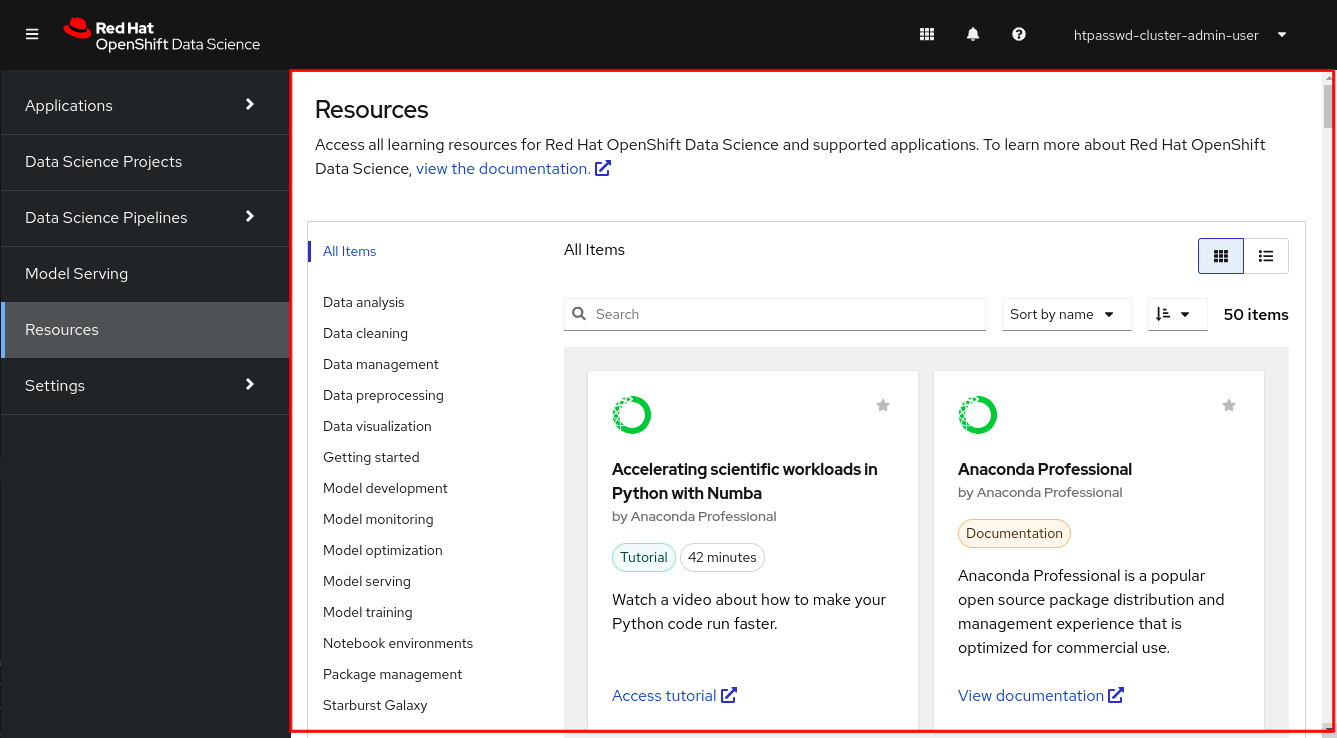

현재 페이지 및 공유 공간을 표시하는 기본 표시 영역은 알림 또는 퀵 스타트 가이드와 같은 정보를 현재 표시하는 서랍과 공유 공간을 표시합니다. 기본 디스플레이 영역에는 노트북 서버를 시작하고 구성하여 mailpyter를 시작할 수 있는 노트북 서버 컨트롤 패널 도 표시됩니다. 관리자는 노트북 서버 컨트롤 패널을 사용하여 다른 사용자의 노트북 서버를 관리할 수도 있습니다.

그림 2.3. 주요 표시 영역

2.1. 글로벌 탐색

상위 탐색에는 네 가지 항목이 있습니다.

-

Toggle 사이드 탐색 메뉴 버튼 (

)은 사이드 탐색이 표시되는지 여부를 전환합니다.

)은 사이드 탐색이 표시되는지 여부를 전환합니다.

-

알림 버튼(

)이 열리고 알림 서랍을 닫아 현재 알림 및 이전 알림을 자세히 읽을 수 있습니다.

)이 열리고 알림 서랍을 닫아 현재 알림 및 이전 알림을 자세히 읽을 수 있습니다.

-

도움말 메뉴(

)는 Red Hat 지원으로 티켓을 생성하고 OpenShift Data Science 설명서에 액세스할 수 있는 링크를 제공합니다.

)는 Red Hat 지원으로 티켓을 생성하고 OpenShift Data Science 설명서에 액세스할 수 있는 링크를 제공합니다.

- User 메뉴에는 현재 로그인한 사용자의 이름이 표시되고 Log out (로그아웃) 버튼에 액세스할 수 있습니다.

2.2. 사이드 탐색

측면 탐색에는 세 가지 주요 섹션이 있습니다.

- 애플리케이션 → 활성화

Enabled (활성화됨) 페이지에는 OpenShift 데이터 과학에서 활성화되고 사용할 준비가 된 애플리케이션이 표시됩니다. 이 페이지는 OpenShift 데이터 과학의 기본 방문 페이지입니다.

애플리케이션 카드에서 애플리케이션 시작 버튼을 클릭하여 새 탭에서 애플리케이션 인터페이스를 엽니다. 애플리케이션에 퀵 스타트 둘러보기가 연결된 경우 애플리케이션 카드의 드롭다운 메뉴를 클릭하고 Open quick start 를 선택하여 액세스할 수 있습니다. 이 페이지에는 관리자가 비활성화한 애플리케이션 및 구성 요소도 표시됩니다. 비활성화된 애플리케이션은 애플리케이션 카드에서

Disabled로 표시됩니다. 애플리케이션 카드에서 Disabled 를 클릭하여 카드를 삭제할 수 있는 링크에 액세스하고 라이센스가 이전에 만료된 경우 해당 라이센스를 다시 무효화합니다.- 애플리케이션 → 탐색

- 탐색 페이지에는 OpenShift 데이터 과학과 함께 사용할 수 있는 애플리케이션이 표시됩니다. 애플리케이션에 대한 자세한 정보 또는 사용 버튼에 액세스하려면 카드를 클릭합니다. Enable 버튼은 애플리케이션에 OpenShift Operator 설치가 필요하지 않은 경우에만 표시됩니다.

- 데이터 교육 프로젝트

- 데이터 과학 프로젝트 페이지를 사용하면 데이터 과학 작업을 단일 프로젝트로 구성할 수 있습니다. 이 페이지에서는 데이터 과학 프로젝트를 생성하고 관리할 수 있습니다. 또한 워크벤치 추가, 프로젝트 클러스터에 스토리지를 추가하고, 데이터 연결을 추가하고, 모델 서버를 추가하여 데이터 과학 프로젝트의 기능을 향상시킬 수 있습니다.

- Data Science Pipelines → Pipelines

- Pipeline 페이지를 사용하면 데이터 사이언스 파이프라인을 가져오고, 관리하고, 추적하고, 볼 수 있습니다. Red Hat OpenShift Data Science Pipeline을 사용하면 머신러닝 워크플로를 표준화하고 자동화하여 데이터 과학 모델을 개발하고 배포할 수 있습니다.

- Data Science Pipelines → Runs

- 실행 페이지를 사용하면 데이터 사이언스 파이프라인의 실행을 정의, 관리 및 추적할 수 있습니다. 파이프라인 실행은 데이터 사이언스 파이프라인의 단일 실행입니다. 또한 데이터 사이언스 프로젝트에 대해 이전에 실행 및 예정된 실행 기록을 볼 수도 있습니다.

- model Serving

- 모델 제공 페이지를 사용하면 배포된 모델의 상태를 관리하고 볼 수 있습니다. 이 페이지를 사용하여 지능형 애플리케이션을 제공하거나 기존 배포된 모델을 볼 수 있는 데이터 사이언스 모델을 배포할 수 있습니다. 배포된 모델의 유추 끝점을 확인할 수도 있습니다.

- Resources

- 리소스 페이지에는 문서, 활용 방법 및 빠른 시작 둘러보기와 같은 학습 리소스가 표시됩니다. 왼쪽에 표시된 옵션을 사용하여 표시 리소스를 필터링하거나 검색 창에 용어를 입력할 수 있습니다.

- 설정 → 노트북 이미지

- Notebook 이미지 설정 페이지를 사용하면 프로젝트의 특정 요구 사항을 충족하는 사용자 정의 노트북 이미지를 구성할 수 있습니다. OpenShift Data Science의 배포에 사용자 정의 노트북 이미지를 추가한 후에는 노트북 서버를 만들 때 선택할 수 있습니다.

- 설정 → 클러스터 설정

클러스터 설정 페이지를 사용하면 클러스터에서 다음 관리 작업을 수행할 수 있습니다.

- 클러스터의 OpenShift 데이터 과학 사용에 대한 데이터를 수집할 수 있는 Red Hat의 기능을 활성화하거나 비활성화합니다.

- 클러스터의 PVC(영구 볼륨 클레임)의 기본 크기를 변경하여 클러스터 내에서 리소스가 클레임되는 방법을 구성합니다.

- 유휴 상태인 노트북 서버를 중지하여 OpenShift 데이터 과학 배포의 리소스 사용량을 줄입니다.

- 허용 오차를 추가하여 테인트된 노드에서 노트북 Pod를 예약합니다.

- 설정 → 사용자 관리

- 사용자 및 그룹 설정 페이지를 사용하면 OpenShift Data Science 사용자 그룹 및 관리자 그룹 멤버십을 정의할 수 있습니다.

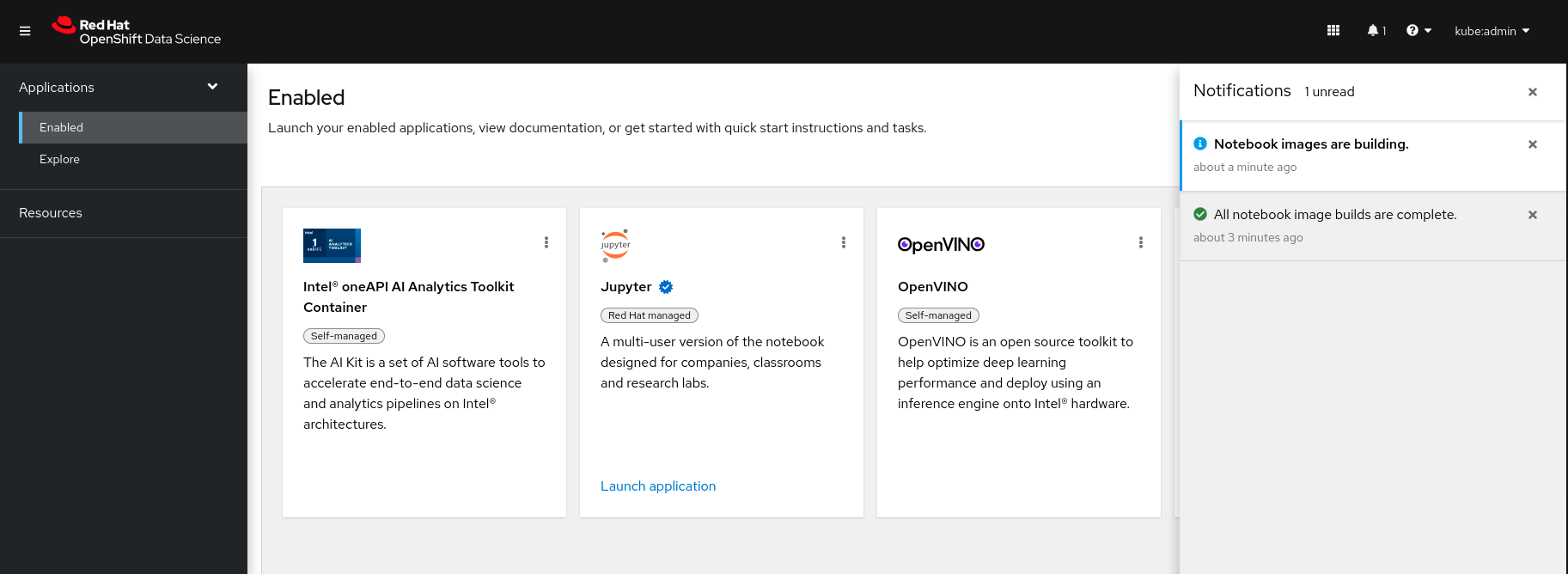

3장. OpenShift 데이터 관련 알림

Red Hat OpenShift Data Science에서는 클러스터에서 중요한 이벤트가 발생할 때 알림을 표시합니다.

알림 메시지가 트리거될 때 Red Hat OpenShift Data Science 인터페이스의 왼쪽 아래에 표시됩니다.

알림 메시지를 놓치는 경우 알림 버튼(

![]() )을 클릭하여 알림 서랍을 열고 읽지 않은 메시지를 확인합니다.

)을 클릭하여 알림 서랍을 열고 읽지 않은 메시지를 확인합니다.

그림 3.1. 알림 서랍

4장. 데이터 과학 프로젝트 생성

데이터 과학 작업을 시작하려면 데이터 과학 프로젝트를 만듭니다. 프로젝트를 생성하면 한 곳에서 작업을 구성하는 데 도움이 됩니다. 또한 워크벤치 추가, 프로젝트 클러스터에 스토리지를 추가하고, 데이터 연결을 추가하고, 모델 서버를 추가하여 데이터 과학 프로젝트의 기능을 향상시킬 수 있습니다.

사전 요구 사항

- Red Hat OpenShift Data Science에 로그인했습니다.

-

특수 OpenShift Data Science 그룹을 사용하는 경우 OpenShift에서 사용자 그룹 또는 관리자 그룹(예:

rhods-users또는rhods-admin)의 일부입니다.

절차

OpenShift Data Science 대시보드에서 Data Science Projects 를 클릭합니다.

데이터 과학 프로젝트 페이지가 열립니다.

Create data Science project를 클릭합니다.

데이터 과학 프로젝트 생성 대화 상자가 열립니다.

- 데이터 과학 프로젝트의 이름을 입력합니다.

- 선택 사항: 데이터 과학 프로젝트의 리소스 이름을 편집합니다. 리소스 이름은 소문자 - 로 구성되어야 하며 영숫자 문자로 시작하고 끝나야 합니다.

- 데이터 과학 프로젝트에 대한 설명을 입력합니다.

생성을 클릭합니다.

프로젝트 세부 정보 페이지가 열립니다. 여기에서 워크벤치를 생성하고, 클러스터 스토리지를 추가하고, 프로젝트에 데이터 연결을 추가할 수 있습니다.

검증

- 사용자가 만든 데이터 과학 프로젝트는 데이터 과학 프로젝트 페이지에 표시됩니다.

5장. 프로젝트 워크벤치 프로젝트 생성

격리된 영역에서 데이터 모델을 검사하고 작업하려면 워크벤치를 만들 수 있습니다. 이 워크벤치를 사용하면 기존에 있는 컨테이너 이미지에서 새로운 줄리터 리테트를 만들어 리소스 및 속성에 액세스할 수 있습니다. 데이터를 유지해야 하는 데이터 과학 프로젝트의 경우 생성 중인 워크벤치에 컨테이너 스토리지를 추가할 수 있습니다.

사전 요구 사항

- Red Hat OpenShift Data Science에 로그인했습니다.

-

특수 OpenShift Data Science 그룹을 사용하는 경우 OpenShift에서 사용자 그룹 또는 관리자 그룹(예:

rhods-users또는rhods-admin)의 일부입니다. - 에 워크벤치를 추가할 수 있는 데이터 사이언스 프로젝트를 생성했습니다.

절차

OpenShift Data Science 대시보드에서 Data Science Projects 를 클릭합니다.

데이터 과학 프로젝트 페이지가 열립니다.

워크벤치를 추가할 프로젝트의 이름을 클릭합니다.

프로젝트의 세부 정보 페이지가 열립니다.

Workbenches 섹션에서 워크벤치 생성 을 클릭합니다.

워크벤치 생성 페이지가 열립니다.

생성 중인 워크벤치의 속성을 구성합니다.

- 워크벤치 이름을 입력합니다.

- 워크벤치에 대한 설명을 입력합니다.

- 워크벤치 서버에 사용할 구성 요소 이미지를 선택합니다.

- 서버의 컨테이너 크기를 선택합니다.

- 선택 사항: 새 환경 변수 의 값을 선택하고 지정합니다.

OpenShift Data Science 클러스터의 스토리지를 구성합니다.

- OpenShift Data Science에서 로그아웃한 후 유지되는 스토리지를 생성하려면 새 영구 스토리지 만들기를 선택합니다. 관련 필드를 채워 스토리지를 정의합니다.

- 기존 영구 스토리지 사용을 선택하여 기존 스토리지를 재사용한 다음 영구 스토리지 목록에서 스토리지 를 선택합니다.

- 워크벤치 만들기를 클릭합니다.

검증

- 생성한 워크벤치는 프로젝트의 세부 정보 페이지에 표시됩니다.

- 생성 프로세스 중 워크벤치와 연관된 클러스터 스토리지가 프로젝트의 세부 정보 페이지에 표시됩니다.

- 세부 정보 페이지의 Workbench 섹션에 있는 Status 열에는 워크벤치 서버가 시작될 때 시작 상태가 표시되고 workbench가 성공적으로 시작되면 Running 상태가 표시됩니다.

5.1. Jupyter 시작 및 노트북 서버 시작

Jupyter를 시작하고 노트북 서버를 시작하여 노트북으로 작업을 시작합니다.

사전 요구 사항

- Red Hat OpenShift Data Science에 로그인했습니다.

-

노트 서버 환경의 환경 변수에 사용하려는 이름과 값(예:

AWS_SECRET_ACCESS_KEY)을 알고 있습니다. - 매우 큰 데이터 세트로 작업하려면 관리자와 협력하여 노트 서버의 저장 용량을 사전에 늘립니다.

절차

- Enabled applications 페이지에서 Jupyter 카드를 찾습니다.

애플리케이션 시작을 클릭합니다.

액세스 권한이 필요한 메시지가 표시되면 기본 사용자 그룹 또는 OpenShift Data Science의 기본 관리자 그룹이 아닙니다. OpenShift Data Science용 사용자 추가 를 사용하여 올바른 그룹에 추가할 수 있도록 관리자에게 문의하십시오.

이전에 계정에 액세스할 수 있는

jupyter-nb-<username> 서비스 계정을 승인 하지 않은 경우 권한 부여 페이지를 입력하라는 메시지가 표시됩니다. 기본적으로 선택한 권한을 검사하고 선택한 권한 허용 버튼을 클릭합니다.인증 정보를 수락하면 노트북 서버 컨트롤 패널이 열리고 시작 노트북 서버 페이지가 표시됩니다.

랩기 서버 시작.

이전에 Jupyter를 개설한 경우에는 이 작업이 필요하지 않습니다.

- 서버에 사용할 참고 북 이미지를 선택합니다.

전자기 이미지에 여러 버전이 포함된 경우 버전 섹션에서 노트 이미지의 버전 을 선택합니다.

참고전자기 이미지의 새 버전이 릴리스되면 이전 버전은 계속 사용 가능하고 클러스터에서 지원됩니다. 이렇게 하면 작업을 최신 버전의 노트북 이미지로 마이그레이션할 수 있습니다.

- 서버 의 컨테이너 크기를 선택합니다.

선택 사항: 서버에 대한 GPU 수 (그래픽 처리 단위)를 선택합니다.

중요GPU를 사용하여 워크로드를 가속화하는 것은 PyTorch, TensorFlow 및 CUDA 노트북 서버 이미지에서만 지원됩니다. 또한 클러스터에서 GPU가 활성화된 경우에만book 서버에 필요한 GPU 수를 지정할 수 있습니다. GPU 지원을 활성화하는 방법을 알아보려면 OpenShift Data Science에서 GPU 지원 활성화를 참조하십시오.

선택 사항: 새 환경 변수에 대한 값을 선택하고 지정합니다.

인터페이스는 이러한 변수를 저장하므로 한 번만 입력해야 합니다. 공통 환경 변수에 대한 예제 변수 이름은 AWS(Amazon Web Services)와 같은 자주 통합된 환경 및 프레임워크에 대해 자동으로 제공됩니다.

중요암호와 같이 비공개로 유지해야 하는 중요한 값이 있는 변수의 Secret 확인란을 선택해야 합니다.

- 선택 사항: 필요한 경우 현재 탭에서 Start server 를 선택합니다.

Start server 를 클릭합니다.

Starting server progress indicator가 표시됩니다. 확장 이벤트 로그 를 클릭하여 서버 생성 프로세스에 대한 추가 정보를 확인합니다. 요청한 배포 크기 및 리소스에 따라 서버를 시작하는 데 최대 몇 분이 걸릴 수 있습니다. 취소 를 클릭하여 서버 생성을 취소합니다.

서버가 시작되면 다음 동작 중 하나가 표시됩니다.

- 이전에 현재 탭에서 Start server를 선택한 경우 웹 브라우저의 현재 탭에서 >-<pyterLab 인터페이스가 열립니다.

이전에 현재 탭에서 서버 시작 확인란을 선택하지 않은 경우 서버 시작 대화 상자에서 새 브라우저 탭 또는 현재 탭에서 서버를 열라는 메시지가 표시됩니다.

selection에 따라 jeepyterLab 인터페이스가 열립니다.

검증

- ECDHEpyterLab 인터페이스가 열립니다.

추가 리소스

문제 해결

- "Unable to load laptop server configuration options" 오류 메시지가 표시되면 관리자에게 문의하여 Jupyter Pod와 관련된 로그를 검토하고 문제에 대한 추가 세부 정보를 확인할 수 있습니다.

5.2. 전자기 서버 환경에 대한 옵션

Jupyter를 처음 시작하거나 노트북 서버를 중지 한 후, 예상되는 소프트웨어와 변수를 서버에서 사용할 수 있도록 노트북 서버 시작 마법사에서 서버 옵션을 선택해야 합니다. 이 섹션에서는 시험 시작 마법사에서 사용할 수 있는 옵션에 대해 자세히 설명합니다.

[ 시작] 서버 페이지는 여러 섹션으로 나뉘어져 있습니다.

- 노트 이미지

랩탑 서버가 기반으로 하는 컨테이너 이미지를 지정합니다. 다른 전자기 이미지에는 기본적으로 설치된 패키지가 서로 다릅니다. 이전 버전에 여러 버전이 포함되어 있는 경우 버전 섹션에서 사용할 이미지 버전을 선택할 수 있습니다.

참고CCO 이미지는 최소 1년 동안 지원됩니다. 사전 구성된 노트북 이미지에 대한 주요 업데이트는 약 6개월마다 생성됩니다. 따라서 일반적으로 두 개의 지원되는 노트북 이미지를 언제든지 사용할 수 있습니다. 최신 패키지 버전을 사용하려면 최근 추가된 제자 이미지를 사용할 것을 권장합니다.

설문지 이미지를 시작한 후 이전 버전에 설치된 Python 패키지 및 전구 셀에서

pip도구를 실행하여 가지고 있는 패키지 버전을 확인할 수 있습니다.다음 표에서는 사용 가능한 노트북 이미지에서 사용되는 패키지 버전을 보여줍니다.

표 5.1. 전자기 이미지 옵션

이미지 이름 이미지 버전 사전 설치된 패키지 CUDA

2 (권장)

- Python 3.9

- CUDA 11.8

- JupyterLab 3.5

- Notebook 6.5

1

- Python 3.8

- CUDA 11.4

- JupyterLab 3.2

- 체크립트 6.4

최소 Python(기본값)

2 (권장)

- Python 3.9

- JupyterLab 3.5

- Notebook 6.5

1

- Python 3.8

- JupyterLab 3.2

- 체크립트 6.4

PyTorch

2 (권장)

- Python 3.9

- JupyterLab 3.5

- Notebook 6.5

- PyTorch 1.13

- CUDA 11.7

- TensorBoard 2.11

- Boto3 1.26

- Kafka-Python 2.0

- Matplotlib 3.6

- numpy 1.24

- Pandas 1.5

- scwit-learn 1.2

- SciPy 1.10

1

- Python 3.8

- JupyterLab 3.2

- 체크립트 6.4

- PyTorch 1.8

- CUDA 10.2

- TensorBoard 2.6

- Boto3 1.17

- Kafka-Python 2.0

- matplotlib 3.4

- numpy 1.19

- pandas 1.2

- Scikit-learn 0.24

- SciPy 1.6

표준 데이터 과학

2 (권장)

- Python 3.9

- JupyterLab 3.5

- Notebook 6.5

- Boto3 1.26

- Kafka-Python 2.0

- Matplotlib 3.6

- Pandas 1.5

- numpy 1.24

- scwit-learn 1.2

- SciPy 1.10

1

- Python 3.8

- JupyterLab 3.2

- 체크립트 6.4

- Boto3 1.17

- Kafka-Python 2.0

- matplotlib 3.4

- pandas 1.2

- numpy 1.19

- Scikit-learn 0.24

- SciPy 1.6

TensorFlow

2 (권장)

- Python 3.9

- JupyterLab 3.5

- Notebook 6.5

- TensorFlow 2.11

- TensorBoard 2.11

- CUDA 11.8

- Boto3 1.26

- Kafka-Python 2.0

- Matplotlib 3.6

- numpy 1.24

- Pandas 1.5

- scwit-learn 1.2

- SciPy 1.10

1

- Python 3.8

- JupyterLab 3.2

- 체크립트 6.4

- TensorFlow 2.7

- TensorBoard 2.6

- CUDA 11.4

- Boto3 1.17

- Kafka-Python 2.0

- matplotlib 3.4

- numpy 1.19

- pandas 1.2

- Scikit-learn 0.24

- SciPy 1.6

TrustyAI

1

- Python 3.9

- JupyterLab 3.5

- Notebook 6.5

- TrustyAI 0.2

- Boto3 1.26

- Kafka-Python 2.0

- Matplotlib 3.6

- numpy 1.24

- Pandas 1.5

- scwit-learn 1.2

- SciPy 1.10

- 배포 크기

노트 서버에서 사용할 수 있는 컴퓨팅 리소스를 지정합니다.

컨테이너 크기는 컨테이너 의 CPU 수, 메모리 양, 최소 및 최대 요청 용량을 제어합니다.

GPU 수는 컨테이너에 연결된 그래픽 처리 장치의 수를 지정합니다.

중요GPU를 사용하여 워크로드를 가속화하는 것은 PyTorch, TensorFlow 및 CUDA 노트북 서버 이미지에서만 지원됩니다. 또한 클러스터에서 GPU가 활성화된 경우에만book 서버에 필요한 GPU 수를 지정할 수 있습니다. GPU 지원을 활성화하는 방법을 알아보려면 OpenShift Data Science에서 GPU 지원 활성화를 참조하십시오.

- 환경 변수

노트 서버에 설정할 변수의 이름과 값을 지정합니다. 서버 시작 시 환경 변수를 설정하면 노트북의 본문이나 Jupyter 명령줄 인터페이스에 정의할 필요가 없습니다. 권장되는 일부 환경 변수는 표에 표시됩니다.

표 5.2. 권장되는 환경 변수

환경 변수 옵션 권장되는 변수 이름 AWS

-

AWS_ACCESS_KEY_ID는 Amazon Web Services의 액세스 키 ID를 지정합니다. -

AWS_SECRET_ACCESS_KEY는AWS_ACCESS_KEY_ID에 지정된 계정의 Secret 액세스 키를 지정합니다.

-

추가 리소스

6장. 데이터 사이언티를 위한 튜토리얼

빠르게 시작할 수 있도록 Red Hat OpenShift Data Science 및 지원되는 애플리케이션의 학습 리소스에 액세스할 수 있습니다. 이러한 리소스는 Red Hat OpenShift Data Science 사용자 인터페이스의 리소스 탭에서 사용할 수 있습니다.

표 6.1. 튜토리얼

| 리소스 이름 | 설명 |

|---|---|

| Numba로 Python에서 과학적인 워크로드 가속화 | Python 코드를 더 빠르게 실행하는 방법에 대한 동영상 보기. |

| Python에서 대화형 시각화 및 대시보드 빌드 | 여러 노트에서 다양한 데이터를 탐색하고 전체 대시보드 및 애플리케이션을 배포하는 방법을 알아봅니다. |

| scikit- learn model을 사용하여 머신 학습 모델 빌드 | 감독되지 않은 학습, 감독되지 않은 학습 및 분류 문제에 대한 scikit- learning 모델을 사용하여 머신 러닝 모델을 구축하는 방법을 알아보십시오. |

| 바이너리 분류 모델 작성 | 고객이 은행 프로모션을 구독할 가능성이 있는지 예측할 수 있도록 모델을 교육합니다. |

| 데이터 시각화를 위한 Python 도구 선택 | PyViz.org 웹 사이트를 사용하면 최상의 오픈 소스 Python 데이터 시각화 도구를 결정할 수 있습니다. |

| 데이터 과학을 위한 Anaconda 탐색 | Python 및 R 프로그래밍 언어의 무료mium 오픈 소스 배포인 Anaconda에 대해 알아봅니다. |

| Pachyderm 개념 시작하기 | 몇 가지 이미지에서 에지 탐지를 수행하는 파이프라인을 생성하여 Pachyderm의 주요 개념을 알아봅니다. |

| Numba가 포함된 Python의 GPU 컴퓨팅 | Numba를 사용하여 GPU 가속 함수를 생성하는 방법을 알아봅니다. |

| Python Note를 실행하여 IBM1.8.0 OpenScale에서 결과를 생성 | Python Note를 실행하여 머신러닝 모델을 생성, 교육 및 배포합니다. |

| 모델 빌드를 위한 AutoAI 실험 실행 | 마케팅 캠페인에 대한 바이너리 분류 모델 구축에 대한 동영상 보기. |

| Pachyderm에서 회귀 모델 교육 | 실험, 데이터 분석 및 회귀 설정을 위해 Pachyderm 클러스터를 사용하여 샘플 제공 데이터 리포지토리를 생성하는 방법을 알아봅니다. |

| 병렬 데이터 분석을 위해 Dask 사용 | 기존 Python 에코시스템을 확장하는 병렬 컴퓨팅 라이브러리인 Dask를 사용하여 중간 크기의 데이터 세트를 병렬로 분석합니다. |

| RuntimeClass Studio에서 gempyter Notes 사용 | KnativeServing Studio에서 Jupyter Notes를 사용하는 방법에 대한 동영상에서 확인하십시오. |

| Python에서 데이터 분석용 Pandas 사용 | Python 프로그래밍 언어용 데이터 분석 라이브러리인 pandas를 사용하는 방법을 알아봅니다. |

표 6.2. 퀵 스타트 가이드

| 리소스 이름 | 설명 |

|---|---|

| 관련 리뷰: Create a Sepyterbook | JupyterLab에 유아노트릭을 만듭니다. |

| NVIDIA GPU 애드온을 사용하여 머신 학습 모델 생성 | 사용 가능한 GPU를 사용하는 Jupyter에서 머신 학습 모델을 생성합니다. |

| Anaconda에서 지원하는 Jupyter Note를 생성 | Anaconda에서 지원하는 Jupyter 유동성을 만들고 보안 및 호환성을 위해 조정된 Anaconda 패키지에 액세스합니다. |

| RuntimeClass Studio로 모델 배포 | EgressIP Studio에서 보조를 가져오고 AutoAI를 사용하여 모델을 빌드하고 배포합니다. |

| Flask 및 OpenShift를 사용하여 샘플 Python 애플리케이션 배포 | 데이터 사이언터 랩탑에서 데이터 사이언트 모델을 배포하고 개발 샌드박스로 사용할 Flask 애플리케이션에 배포하십시오. |

| Pachyderm Beginner Tutorial Notebook 가져오기 | Pachyderm의 초보기 튜토리얼의 노트와 데이터 리포지토리, 파이프라인과 같은 Pachyderm의 주요 개념에 대해 알아보고 셀에서 pachctl CLI를 사용하는 방법을 알아보십시오. |

| NVIDIA GPU 애드온 설치 및 확인 | Jupyter가 사용할 수 있는 GPU를 탐지하는 방법을 설치하고 확인하는 방법을 배웁니다. |

| 카나리아 배포로 SKLearning 모델 열기 및 업데이트 | SK learn 모델을 열고 카나리아 배포 사례를 사용하여 업데이트합니다. |

| Starburst Galaxy를 사용하여 데이터 쿼리 | Jupyter 노트북에서 Starburst Galaxy를 사용하여 데이터를 쿼리하는 방법을 알아보십시오. |

| Red Hat OpenShift API Management를 사용하여 배포된 모델 보안 | Red Hat OpenShift API Management를 사용하여 모델 서비스 API 보호. |

| Intel® oneAPI AI analytics Toolkit (AI Kit) Notebook 사용 | Intel® oneAPI AI analytics Toolkit을 사용하여 데이터 사이언트릭스를 실행합니다. |

| OpenVINO 툴킷 사용 | OpenVINO 모델 Optimizer를 사용하여 ONNX 컴퓨터 시력 모델을 정량화하고, 노트북의 결과를 사용합니다. |

표 6.3. 안내하는 방법

| 리소스 이름 | 설명 |

|---|---|

| 전자기 런타임 환경 옵션 중에서 선택하는 방법 | 전자기 런타임 환경 구성에 사용할 수 있는 옵션을 살펴봅니다. |

| 데이터 정리, 모양 및 시각화 방법 | IBM ClusterRole Studio 데이터 구체화를 사용하여 테이블 형식 데이터를 정리하고 셰이핑하는 방법을 알아봅니다. |

| 데이터에 액세스하기 위한 연결을 만드는 방법How to create a connection to access data | 플랫폼에서 다양한 데이터 소스에 대한 연결을 만드는 방법을 알아봅니다. |

| 배포 공간 생성 방법 | 머신러닝을 위한 배포 공간을 만드는 방법에 대해 알아봅니다. |

| 다이언스 Studio에서 전자상선을 만드는 방법 | OSSM Studio에서 기본 유파터 랩을 만드는 방법에 대해 알아보십시오. |

| 다이언스 Studio에서 프로젝트를 만드는 방법 | RuntimeClass Studio에서 분석 프로젝트를 만드는 방법에 대해 알아봅니다. |

| Git과 통합되는 프로젝트를 생성하는 방법 | Git 리포지토리의 자산을 프로젝트에 추가하는 방법을 알아봅니다. |

| 전자기 서버에 Python 패키지를 설치하는 방법 | Note 서버에 추가 Python 패키지를 설치하는 방법을 알아보십시오. |

| Sementter Note Note로 데이터를 로드하는 방법 | 데이터를 로드하여 data sources를 Jupyter DHCP에 통합하는 방법을 알아봅니다. |

| OpenVINO Model Server를 사용하여 모델을 제공하는 방법 | OpenVINO 사용자 지정 리소스를 사용하여 OpenVINO Model Server를 사용하여 최적화된 모델을 배포하는 방법을 알아봅니다. |

| EgressIP OpenScale 설정 방법 | OpenScale을 사용하여 모델의 결과를 추적하고 측정하는 방법을 알아봅니다. |

| Notebook 서버 설정을 업데이트하는 방법 | 노트 서버에서 설정 또는 노트 이미지를 업데이트하는 방법을 알아보십시오. |

| Amazon S3 버킷의 데이터 사용 방법 | 환경 변수를 사용하여 S3 Storage의 데이터에 연결하는 방법을 알아봅니다. |

| 노트북 서버에 설치된 패키지를 보는 방법 | 실행중인 Note 서버에 어떤 패키지가 설치되어 있는지 확인하는 방법을 알아보십시오. |

6.1. 튜토리얼 액세스

Red Hat OpenShift Data Science 및 지원되는 애플리케이션의 학습 리소스에 액세스할 수 있습니다.

사전 요구 사항

- Red Hat OpenShift Data Science에 로그인했는지 확인합니다.

- OpenShift Dedicated 웹 콘솔에 로그인했습니다.

절차

Red Hat OpenShift Data Science 홈 페이지에서 리소스 를 클릭합니다.

리소스 페이지가 열립니다.

- 관련 카드에서 Access 튜토리얼을 클릭합니다.

검증

- Red Hat OpenShift Data Science 및 지원되는 애플리케이션을 위한 학습 리소스를 보고 액세스할 수 있습니다.

추가 리소스

7장. OpenShift 데이터 과학에 연결된 서비스 활성화

Red Hat OpenShift Data Science에서 사용하기 전에 Anaconda Professional Edition과 같은 SaaS 기반 서비스를 활성화해야 합니다. 클러스터 내 서비스가 자동으로 활성화됩니다.

일반적으로 다음 방법 중 하나를 사용하여 서비스를 설치하거나 OpenShift Data Science에 연결된 서비스를 활성화할 수 있습니다.

- 다음 절차에 설명된 대로 OpenShift Data Science 대시보드의 탐색 페이지에서 서비스를 활성화합니다.

OperatorHub에서 서비스용 Operator 설치. OperatorHub는 클러스터 관리자가 클러스터에 설치할 Operator를 검색하고 선택할 수 있는 웹 콘솔입니다. OpenShift Container Platform (웹 콘솔을 사용하여 OperatorHub에서 설치)에 기본적으로 배포됩니다.

참고OperatorHub에서 설치된 Operator가 포함된 배포는 Red Hat에서 완전히 지원하지 않을 수 있습니다.

- Red Hat Marketplace(Install Operators)에서 서비스용 Operator 설치.

- OpenShift Dedicated 클러스터에 대한 애드온으로 서비스 설치(클러스터에Operator 추가).

일부 서비스(예: metapyter)의 경우 서비스 엔드포인트는 OpenShift Data Science의 활성화된 페이지에 있는 서비스 타일에서 사용할 수 있습니다. 특정 서비스는 타일에서 직접 액세스할 수 없습니다. 예를 들어 OpenVINO 및 Anaconda는 Jupyter에서 사용할 노트북 이미지를 제공하며 타일에서 끝점 링크를 제공하지 않습니다. 또한 이러한 엔드 포인트 URL을 환경 변수로 저장하여 설문지 환경에서 쉽게 참조할 수 있도록 하는 것이 유용할 수 있습니다.

리소스 페이지에서 서비스 학습 리소스 및 문서에 액세스하거나 사용 가능한 페이지에서 서비스 타일의 관련 링크를 클릭하여 빠르게 시작할 수 있습니다.

사전 요구 사항

- OpenShift 데이터 과학에 로그인되어 있습니다.

- 관리자가 OpenShift 클러스터에 서비스를 설치하거나 구성했습니다.

절차

OpenShift 데이터 과학 홈 페이지에서 탐색을 클릭합니다.

탐색 페이지가 열립니다.

- 활성화할 서비스 카드를 클릭합니다.

- 서비스에 대해 서랍에서 사용을 클릭합니다.

- 메시지가 표시되면 서비스 키를 입력하고 연결을 클릭합니다.

- Enable 을 클릭하여 서비스를 활성화 중인지 확인합니다.

검증

- 활성화한 서비스가 Enabled 페이지에 표시됩니다.

- 서비스 끝점은 사용됨 페이지의 서비스 타일에 표시됩니다.

8장. OpenShift 데이터 과학에 연결된 애플리케이션 비활성화

예를 들어 데이터 사이언티스가 더 이상 애플리케이션을 사용하지 않거나 애플리케이션의 라이센스가 만료되면 애플리케이션 및 구성 요소를 비활성화하여 더 이상 사용하지 않을 때 OpenShift 데이터 과학 대시보드에 표시되지 않도록 할 수 있습니다.

사용하지 않는 애플리케이션을 비활성화하면 데이터 사이언티스트가 OpenShift Data Science 대시보드에서 이러한 애플리케이션 카드를 수동으로 제거하여 사용할 가능성이 높은 애플리케이션에 집중할 수 있습니다. 애플리케이션 카드를 수동으로 제거하는 방법에 대한 자세한 내용은 OpenShift Data Science에서 비활성화된 애플리케이션 제거를 참조하십시오.

다음 애플리케이션을 비활성화할 때 다음 절차를 수행하지 마십시오.

- Anaconda Professional Edition. Anaconda Professional Edition을 수동으로 비활성화할 수 없습니다. 라이센스가 만료될 때만 자동으로 비활성화됩니다.

- Red Hat OpenShift API Management. OpenShift Cluster Manager에서 Red Hat OpenShift API Management를 설치 제거할 수 있습니다.

- OpenShift Dedicated 웹 콘솔에 로그인했습니다.

-

OpenShift Dedicated의

cluster-admins사용자 그룹의 일부입니다. - OpenShift Dedicated 클러스터에 서비스를 설치 또는 구성했습니다.

- 사용하지 않으려면 애플리케이션 또는 구성 요소가 활성화되어 있으며 사용 가능 페이지에 표시됩니다.

절차

- OpenShift Dedicated 웹 콘솔에서 관리자 화면으로 변경합니다.

-

redhat-ods-applications프로젝트로 변경합니다. - Operators → 설치된 Operators를 클릭합니다.

- 제거할 Operator를 클릭합니다. Operator를 더 빠르게 찾을 수 있도록 이름으로 필터링 필드에 키워드를 입력할 수 있습니다.

Operator 인터페이스의 탭을 사용하여 Operator 리소스 또는 인스턴스를 삭제합니다.

설치 중에 일부 Operator는 관리자가 리소스를 생성하거나 Operator 인터페이스의 탭을 사용하여 프로세스 인스턴스를 시작해야 합니다. Operator를 올바르게 제거하려면 먼저 삭제해야 합니다.

Operator 세부 정보 페이지에서 작업 드롭다운 메뉴를 클릭하고 Operator 설치 제거를 선택합니다.

Operator를 설치 제거하시겠습니까? 대화 상자가 표시됩니다.

- 설치 제거를 선택하여 Operator, Operator 배포 및 Pod를 설치 제거합니다. 이 작업이 완료되면 Operator가 실행을 중지하고 더 이상 업데이트를 수신하지 않습니다.

Operator를 제거해도 Operator의 사용자 정의 리소스 정의 또는 관리 리소스는 제거되지 않습니다. 사용자 정의 리소스 정의 및 관리 리소스는 여전히 존재하며 수동으로 정리해야 합니다. Operator 및 구성된 모든 클러스터 외부 리소스가 계속 실행되며 수동으로 정리해야 합니다.

검증

- 대상 클러스터에서 Operator가 설치 제거됩니다.

- 설치된 Operator 페이지에 Operator가 더 이상 표시되지 않습니다.

-

비활성화된 애플리케이션은 더 이상 사용자 데이터 사이언티스트가 사용할 수 없으며 OpenShift Data Science 대시보드의 Enabled 페이지에서

Disabled로 표시됩니다. Operator를 제거한 후 이 작업을 수행하는 데 몇 분이 걸릴 수 있습니다.

8.1. OpenShift Data Science에서 비활성화된 애플리케이션 제거

관리자가 사용하지 않는 애플리케이션을 비활성화한 후 Red Hat OpenShift Data Science 대시보드에서 수동으로 제거할 수 있습니다. 사용하지 않는 애플리케이션을 비활성화하고 제거하면 가장 많이 사용되는 애플리케이션에 중점을 둘 수 있습니다.

사전 요구 사항

- Red Hat OpenShift Data Science에 로그인했는지 확인합니다.

- OpenShift Dedicated 웹 콘솔에 로그인했습니다.

- 관리자가 이전에 삭제하려는 애플리케이션을 비활성화했습니다.

절차

OpenShift Data Science 인터페이스에서 Enabled (활성화)를 클릭합니다.

Enabled 페이지가 열립니다. 비활성화된 애플리케이션은 애플리케이션의 카드에서

Disabled로 표시됩니다.- 제거할 애플리케이션 카드에서 Disabled 를 클릭합니다.

- 링크를 클릭하여 애플리케이션 카드를 제거합니다.

검증

- 비활성화된 애플리케이션의 카드가 더 이상 Enabled 페이지에 표시되지 않습니다.

9장. 지원 요구 사항 및 제한 사항

이 섹션을 검토하여 Red Hat 지원 요구 사항 및 Red Hat OpenShift Data Science의 Red Hat 지원에 대한 제한 사항을 확인하십시오.

9.1. 지원되는 브라우저

Red Hat OpenShift Data Science는 다음 브라우저의 최신 버전을 지원합니다.

- Google Chrome

- Mozilla Firefox

- Safari

9.2. 지원되는 서비스

Red Hat OpenShift Data Science는 다음 서비스를 지원합니다.

표 9.1. 지원되는 서비스

| 서비스 이름 | 설명 |

|---|---|

| Anaconda Professional Edition | Anaconda Professional Edition은 상업적으로 사용하기에 최적화된 인기 있는 오픈 소스 패키지 배포 및 관리 경험입니다. |

| IBM Watson Studio | IBM RuntimeClass Studio는 비즈니스에 AI 및 머신 러닝을 내장하고 자체 데이터로 사용자 지정 모델을 만들기 위한 플랫폼입니다. |

| Intel® oneAPI AI analytics Toolkits | AI Kit는 Intel® 아키텍처에서 엔드 투 엔드 데이터 사이언티스 및 분석 파이프라인을 가속화하는 AI 소프트웨어 툴 세트입니다. |

| Jupyter | Jupyter는 회사, 교실 및 연구 랩을 위해 설계된 노트북의 다중 사용자 버전입니다. 중요 OpenShift 노드 장애, 업그레이드 및 유사한 중단 작업에 대한 Red Hat OpenShift Data technology를 탄력적으로 만들기 위해 노력하지만 이러한 이벤트 중에 개별 사용자의 보조 환경이 중단될 수 있습니다. OpenShift 노드를 재시작하거나 사용할 수 없는 경우 해당 노드의 모든 사용자 전자기 환경이 다른 노드에서 다시 시작됩니다. 이러한 상황이 발생하면 사용자의 노트 환경에서 실행 중인 프로세스가 중단되고 사용자는 해당 환경을 다시 사용할 수 있게 되면 이를 다시 실행해야 합니다. 이러한 제한으로 인해 Red Hat은 중단이 허용되지 않는 프로세스가 OpenShift Data Science의 Jupyter 노트북 서버 환경에서 실행되지 않는 것이 좋습니다. |

| Pachyderm | Pachyderm의 데이터 버전 관리, 파이프라인 및 라인지 기능을 사용하여 머신 학습 라이프사이클을 자동화하고 머신러닝 운영을 최적화합니다. 참고

Pachyderm이 의도적으로 생성하는 |

| Red Hat OpenShift API Management | OpenShift API Management는 가치 실현 시간을 단축하고 API 우선 마이크로 서비스 기반 애플리케이션을 제공하는 비용을 줄이는 서비스입니다. |

| OpenVINO | OpenVino는 Intel 하드웨어에 유추 엔진을 사용하여 딥 러닝 성능과 배포를 지원하는 오픈 소스 툴킷입니다. |

| Starburst Galaxy | Starburst Galaxy는 SQL을 사용하여 다양한 데이터 소스에서 고성능 쿼리를 실행하는 완전 관리형 서비스입니다. |

9.3. 지원되는 패키지

Red Hat OpenShift Data Science에서 지원되는 최신 노트북 서버 이미지는 기본적으로 Python과 함께 설치됩니다. 이러한 이미지에 포함된 패키지 및 버전의 전체 목록은 옵션 테이블을 참조하십시오.

지원되는 Python 버전과 호환되는 패키지를 해당 패키지에 필요한 바이너리가 있는 모든 이전 서버에 설치할 수 있습니다. 사용하려는 전자기 서버 이미지에 필요한 바이너리가 포함되어 있지 않은 경우 Red Hat 지원팀에 문의하여 바이너리를 포함시키도록 요청하십시오.

pip install 명령을 사용하여 일시적으로 패키지를 설치할 수 있습니다. requirements.txt 파일을 사용하여 pip install 명령에 패키지 목록을 제공할 수도 있습니다. 자세한 내용은 Installing Python packages on your logger server 에서 참조하십시오.

이 패키지를 설치 한 후 미리 설치 해야 합니다.You must re-install these packages each time you start.

pip uninstall 명령을 사용하여 패키지를 제거할 수 있습니다.

10장. 일반적인 질문

문서 외에도 Red Hat은 OpenShift Data Science 및 지원되는 애플리케이션에 대한 풍부한 학습 리소스 세트를 제공합니다.

OpenShift Data Science 대시보드의 리소스 페이지에서 카테고리 링크를 사용하여 데이터 사이언스 워크플로우의 다양한 단계에 대한 리소스를 필터링할 수 있습니다. 예를 들어 모델 제공 범주를 클릭하여 모델 배포 방법을 설명하는 리소스를 표시합니다. 모든 항목을 클릭하여 모든 카테고리의 리소스를 표시합니다.

선택한 카테고리의 경우 추가 옵션을 적용하여 사용 가능한 리소스를 필터링할 수 있습니다. 예를 들어 방법-투 기사, 퀵 스타트, 튜토리얼과 같은 유형별로 필터링할 수 있습니다. 이러한 리소스는 일반적인 질문에 대한 답변을 제공합니다.

11장. 관리자용 Jupyter의 일반적인 문제 해결

사용자가 Jupyter, 노트북 또는 노트북 서버와 관련된 Red Hat OpenShift Data Science에서 오류가 발생하는 경우 이 섹션을 읽고 문제를 일으키는 원인과 문제를 해결하는 방법을 알아보십시오.

여기에서 또는 릴리스 노트에서 문제가 표시되지 않는 경우 Red Hat 지원에 문의하십시오.

11.1. 사용자는 404를 수신합니다. page not found error when logged in to / Umapyter에 로그인할 때 오류가 발생했습니다.

문제

특수 OpenShift Data Science 사용자 그룹을 구성한 경우 사용자 이름이 OpenShift Data Science의 기본 사용자 그룹에 추가되지 않을 수 있습니다.

진단

사용자가 기본 사용자 그룹의 일부인지 확인합니다.

- Jupyter에 액세스할 수 있는 그룹 이름을 찾습니다.

- OpenShift Dedicated 웹 콘솔에 로그인합니다.

- 사용자 관리 → 그룹을 클릭합니다.

사용자 그룹의 이름을 클릭합니다(예:

rhods-users).해당 그룹의 그룹 세부 정보 페이지가 표시됩니다.

- 그룹의 세부 정보 탭을 클릭하고 관련 그룹의 Users 섹션에 givespyter 액세스 권한이 있는 사용자가 포함되어 있는지 확인합니다.

해결

- 사용자가 Jupyter에 액세스할 수 있는 그룹에 추가되지 않은 경우, Add users for OpenShift Data Science to add them.

- 사용자가 이미 Jupyter에 액세스할 수 있는 그룹에 추가된 경우 Red Hat 지원팀에 문의하십시오.

11.2. 사용자의 노트북 서버가 시작되지 않습니다.

사용자의 노트북 서버를 호스팅하는 OpenShift Dedicated 클러스터는 충분한 리소스에 액세스할 수 없거나 Jupyter Pod가 실패할 수 있습니다.

- OpenShift Dedicated 웹 콘솔에 로그인합니다.

이 사용자에 대한book 서버 Pod를 삭제하고 다시 시작합니다.

-

워크로드 → 포드 를 클릭하고 프로젝트를

rhods-notebook로 설정합니다. 이 사용자에 속하는 노트북 서버 Pod(예:

jupyter-nb-<username>-*)를 검색합니다.노트 서버 Pod가 존재하는 경우, 노트 서버 Pod에서 간헐적인 오류가 발생했을 수 있습니다.

사용자에 대한 랩기 서버 Pod가 없으면 진단을 계속합니다.

-

워크로드 → 포드 를 클릭하고 프로젝트를

선택한 구성 요소 서버 이미지에 필요한 리소스에 대해 현재 OpenShift 클러스터에서 사용 가능한 리소스를 확인합니다.

충분한 CPU 및 RAM이 있는 작업자 노드를 클러스터에서 예약할 수 있는 경우 진단을 계속합니다.

- Jupyter Pod의 상태를 확인합니다.

해결

노트 서버 Pod가 간헐적으로 실패하는 경우:

- 사용자에 속하는 랩기 서버 Pod를 삭제합니다.

- 사용자에게 전자기 서버를 다시 시작하도록 요청합니다.

- 이 서버에 선택한 구성 요소 서버 이미지를 실행하기에 충분한 리소스가 없는 경우 OpenShift 클러스터에 더 많은 리소스를 추가하거나 작은 이미지 크기를 선택합니다.

Jupyter Pod가 FAILED 상태인 경우:

-

jupyter-nb-*Pod의 로그를 검색하여 추가 평가를 위해 Red Hat 지원팀으로 보냅니다. -

jupyter-nb-*Pod를 삭제합니다.

-

- 이전 해결이 적용되지 않는 경우 Red Hat 지원에 문의하십시오.

11.3. 사용자가 데이터베이스를 수신하거나 디스크가 전체 오류이거나 노트북 셀을 실행할 때 장치 오류에 남아 있는 공간이 없습니다.

문제

사용자는 노트북 서버에 저장 공간이 부족했을 수 있습니다.

진단

- Jupyter에 로그인하고 사용자에게 문제가 있는 노트북 서버를 시작합니다. 노트북 서버가 시작되지 않는 경우 다음 단계에 따라 사용자가 저장 공간이 부족했는지 확인합니다.

- OpenShift Dedicated 웹 콘솔에 로그인합니다.

-

워크로드 → 포드 를 클릭하고 프로젝트를

rhods-notebook로 설정합니다. -

이 사용자에 속하는 노트북 서버 포드(예:

jupyter-nb-<idp>-<username>-*)를 클릭합니다. 로그를 클릭합니다. 다음과 유사한 행이 표시되면 사용자가 사용 가능한 용량을 초과했습니다.

Unexpected error while saving file: XXXX database or disk is full

해결

- 영구 볼륨을 확장하여 사용자 사용 가능한 스토리지를 늘립니다. 영구 볼륨 확장

-

사용자와 협력하여 노트북 서버의

/opt/app-root/src디렉토리에서 삭제할 수 있는 파일을 식별하여 기존 스토리지 공간을 확보합니다.

12장. 사용자를 위한 Jupyter의 일반적인 문제 해결

Jupyter, 노트북 또는 노트북 서버와 관련된 Red Hat OpenShift Data Science에서 오류가 표시되면 이 섹션을 참조하여 문제를 일으킬 수 있는 내용을 알아보십시오.

문제가 표시되지 않거나 릴리스 노트에 있는 경우 Red Hat 지원팀에 문의하십시오.

12.1. 403을 참조하십시오. forbidden 오류 발생 시 Jupyter에 로그인

문제

관리자가 특수 OpenShift Data Science 사용자 그룹을 구성한 경우 사용자 이름이 기본 사용자 그룹 또는 OpenShift Data Science용 기본 관리자 그룹에 추가되지 않을 수 있습니다.

해결

Contact your administrator so that they can add you to the correct group/s.

12.2. 내 노트 서버가 시작되지 않습니다.

노트북 서버를 호스팅하는 OpenShift Dedicated 클러스터는 충분한 리소스에 액세스할 수 없거나 Jupyter Pod가 실패할 수 있습니다.

해결

문제와 관련된 오류 메시지의 경우 OpenShift의 Events 섹션의 로그를 확인합니다. 예를 들어 다음과 같습니다.

Server requested

2021-10-28T13:31:29.830991Z [Warning] 0/7 nodes are available: 2 Insufficient memory,

2 node(s) had taint {node-role.kubernetes.io/infra: }, that the pod didn't tolerate, 3 node(s) had taint {node-role.kubernetes.io/master: },

that the pod didn't tolerate.추가 검사를 수행할 수 있도록 관련 오류 메시지의 세부 정보를 관리자에게 문의하십시오.

12.3. 데이터베이스 또는 디스크가 전체 오류이거나 장치 오류 발생 시 아무 공간도 볼 수 없습니다.

문제

노트 서버의 저장 공간이 부족할 수 있습니다.

해결

추가 검사를 수행할 수 있도록 관리자에게 문의하십시오.