Red Hat Hyperconverged Infrastructure 배포

Red Hat Hyperconverged Infrastructure 배포 지침

Laura Bailey

lbailey@redhat.com초록

1장. 알려진 문제

이 섹션은 Red Hat Hyperconverged Infrastructure(RHHI)에 영향을 미치는 알려진 예상치 못한 동작에 대해 설명합니다.

- BZ#1395087 - 네트워크를 사용할 수 없을 때 무기한으로 일시 정지되는 가상 머신

- Gluster 및 마이그레이션 트래픽의 네트워크를 사용할 수 없게 되면 I/O를 수행하는 가상 머신에 액세스할 수 없게 되며 하이퍼바이저를 재부팅할 때까지 다른 노드로의 마이그레이션을 완료할 수 없습니다. 이는 현재 펜싱 및 마이그레이션 방식에 예상되는 동작입니다. 현재 이 문제를 해결할 수 있는 방법은 없습니다.

- BZ#1401969 - 복구 소스가 되는 Arbiter 브릭

- Arbiter 볼륨의 데이터 브릭을 오프라인으로 가져온 다음 다시 온라인으로 한 번에 하나씩 가져오면 다른 브릭을 복구하는 경우 Arbiter 브릭이 올바른 데이터의 소스로 식별되지 않습니다. Arbiter 브릭에는 메타데이터만 포함되어 있으므로 가상 머신이 일시 정지됩니다. 현재 이 문제를 해결할 수 있는 방법은 없습니다.

- BZ#1412930 - TLS/SSL이 활성화된 경우 스토리지를 사용할 수 없을 때의 과도한 로깅

- Transport Layer Security(TLS/SSL)가 Red Hat Gluster Storage 볼륨에서 활성화되고 Red Hat Gluster Storage 서버를 사용할 수 없게 되면 Red Hat Gluster Storage 서버를 다시 사용할 수 있게 될 때까지 다량의 연결 오류 메시지가 로그됩니다. 재연결 시도 후 로그된 메시지가 하위 로그 메시지로 변경되지 않으므로 이 문제가 발생됩니다. 현재 이 문제를 해결할 수 있는 방법은 없습니다.

- BZ#1413845 - 관리 네트워크를 사용할 수 없는 경우 마이그레이션하지 않는 호스트 엔진

- 마이그레이션 동안 관리 네트워크를 사용할 수 없게 되면 호스트 엔진 가상 머신이 다시 시작되지만 호스트 엔진 자체는 다시 시작되지 않습니다. 이 문제를 해결하려면 ovirt-engine 서비스를 수동으로 다시 시작하십시오.

- BZ#1425767 - 실패하지 않는 온전성 검사 스크립트

-

온전성 검사 스크립트는 디스크가 없거나 비어있지 않더라도 0(성공)을 반환하는 경우가 있습니다. 온전성 검사가 성공으로 표시되므로 gdeploy는 물리 볼륨 생성을 시도하고 실패합니다. 이 문제를 해결하려면 gdeploy 구성 파일의

disk값이 올바른지 확인하고 디스크에 파티션 또는 레이블이 없는지 확인한 다음 배포를 다시 시도하십시오.

- BZ#1432326 - 네트워크를 호스트에 연결하면 네트워크가 동기화되지 않음

- Gluster 네트워크가 Red Hat Gluster Storage 노드의 네트워크 인터페이스에 연결되는 경우 Gluster 네트워크가 비동기화 상태가 됩니다. 이 문제를 해결하려면 노드에 해당하는 관리 탭을 클릭하고 기능 새로고침을 클릭합니다.

- BZ#1434105 - 라이브 스토리지 마이그레이션 실패

- 마이그레이션 동안 I/O 작업이 계속 진행 중인 경우 Gluster 기반 스토리지 도메인의 라이브 마이그레이션이 실패합니다. 현재 이 문제를 해결할 수 있는 방법이 없습니다.

- BZ#1437799 - SSH를 사용한 Gluster 스토리지 도메인에 ISO 업로드 실패

SSH를 사용하여 Gluster 기반 스토리지 도메인에 ISO를 업데이트하는 경우

ovirt-iso-uploader도구에서 잘못된 경로를 사용하여 그 결과 다음과 같은 오류가 발생합니다.OSError: [Errno 2] No such file or directory: '/ISO_Volume' ERROR: Unable to copy RHGSS-3.1.3-RHEL-7-20160616.2-RHGSS-x86_64-dvd1.iso to ISO storage domain on ISODomain1. ERROR: Error message is "unable to test the available space on /ISO_Volume

이 문제를 해결하려면 Gluster 볼륨에서 NFS 액세스를 활성화하고 SSH 대신 NFS를 사용하여 업로드하십시오.

- BZ#1439069 - /etc/ovirt-hosted-engine/hosted-engine.conf를 덮어쓰는 노드 재설치

기본 Red Hat Gluster Storage 서버를 변경한 후 노드가 재설치되면

/etc/ovirt-hosted-engine/hosted-engine.conf파일의 컨텐츠가 이전 기본 호스트의 상세 정보로 덮어쓰기됩니다. 이를 통해 클러스터는 비작동 상태가 됩니다.이 문제를 해결하려면 재설치한 노드를 유지 관리 모드로 이동하고 변경 기본 서버를 지정하도록

/etc/ovirt-hosted-engine/hosted-engine.conf의 컨텐츠를 업데이트합니다. 그런 다음 재설치한 노드를 재부팅하고 재활성화하여 온라인 상태로 모든 볼륨을 마운트합니다.- BZ#1443169 - 브리지를 구성하는 동안 호스트 엔진 배포 실패

-

연결된 네트워크 구성을 사용하여 셀프 호스트 엔진을 시스템에 설정하는 경우 firewalld 서비스를 다시 시작한 후 설정에 실패합니다. 이 문제를 해결하려면 셀프 호스트 엔진을 배포하기 전에

/etc/sysconfig/network-scripts/디렉토리에서 모든*.bak파일을 제거합니다.

I 부. 계획

2장. 아키텍처

Red Hat Hyperconverged Infrastructure(RHHI)는 컴퓨팅, 스토리지, 네트워킹 및 관리 기능을 하나의 배포로 통합합니다.

RHHI는 세 대의 물리 머신에 배포되어 Red Hat Gluster Storage 3.2 및 Red Hat Virtualization 4.1을 사용하는 별개의 클러스터 또는 pod를 생성합니다.

이 배포의 주된 사용처는 원격 오피스 및 지사 (ROBO: Remote Office Branch Office) 환경으로 원격 오피스가 정기적으로 중앙 데이터 센터에 데이터를 동기화하지만 중앙 데이터 센터에 연결하지 않고도 작동합니다.

다음 다이어그램에서는 단일 클러스터의 기본 아키텍처를 보여줍니다.

3장. 지원 요구 사항

이 섹션을 검토하여 계획한 배포가 Red Hat의 지원 요구 사항을 충족하는지 확인하십시오.

3.1. 운영 체제

Red Hat Hyperconverged Infrastructure(RHHI)는 Red Hat Virtualization Host 4.1에서만 지원됩니다. 다른 모든 설정은 Red Hat Virtualization Host 4.1을 기반으로 사용하십시오.

Red Hat Virtualization의 자세한 요구 사항은 Red Hat Virtualization 설치 가이드를 참조하십시오. https://access.redhat.com/documentation/en-us/red_hat_virtualization/4.1/html/installation_guide/chap-system_requirements

3.2. 물리 머신

Red Hat Hyperconverged Infrastructure(RHHI)에는 최소 3개의 물리 머신이 필요합니다. 6개 물리 머신 또는 9개 물리 머신으로의 확장도 지원됩니다.

각 물리 머신에는 다음과 같은 기능이 있어야 합니다.

- 데이터 및 관리 트래픽 분리를 위한 물리 머신당 최소 2개의 NIC(자세한 내용은 3.4절. “네트워킹” 참조)

소형 배포의 경우:

- 최소 12개 코어

- 최소 64GB RAM

- 최대 48TB 스토리지

중간급 배포의 경우:

- 최소 12개 코어

- 최소 128GB RAM

- 최대 64TB 스토리지

대형 배포의 경우:

- 최소 16개 코어

- 최소 256GB RAM

- 최대 80TB 스토리지

3.3. 가상 머신

각 가상 머신은 최대 4개의 가상 CPU와 2TB의 가상 디스크 공간을 보유할 수 있습니다.

지원되는 가상 머신의 수는 크기와 리소스 사용량에 따라 다릅니다.

3.4. 네트워킹

클러스터의 클라이언트 및 관리 트래픽이 분리되도록 두 개의 구분된 네트워크가 필요합니다.

- 프런트 엔드 네트워크

ovirt 관리의 네트워크 브리지로 사용됩니다.

- 프런트 엔드 네트워크에 할당된 IP 주소는 동일한 서브넷에 있어야 하며 백엔드 IP 주소와는 다른 서브넷이어야 합니다.

- 백엔드 네트워크

스토리지 피어 간 스토리지 및 마이그레이션 트래픽에 사용됩니다.

- Red Hat은 백엔드 네트워크에 10Gbps의 네트워크를 권장합니다.

- Red Hat Gluster Storage에는 피어 간 5밀리초의 최대 대기 시간이 필요합니다.

- 백엔드 네트워크에 할당된 IP 주소는 동일한 서브넷에 있어야 하며 프런트 엔드 IP 주소와는 다른 서브넷이어야 합니다.

모든 호스트의 FQDN 및 호스트 엔진 가상 머신의 FQDN은 DNS에서 정방향/역방향 이름 확인이 가능해야 합니다.

DHCP 서버는 호스트 엔진 가상 머신의 DHCP 네트워크 구성을 선택하는 경우 필요합니다.

3.5. 스토리지

3.5.1. 아키텍처

단일 Red Hat Gluster Storage 클러스터는 3-4개의 볼륨을 보유할 수 있습니다.

- 셀프 호스트 엔진 용 1개의 엔진 볼륨

- 가상 머신 부트 디스크 이미지 용 1개의 vmstore 볼륨

- 기타 가상 머신 디스크 이미지 용 1개의 옵션 데이터 볼륨

- 지역 복제 메타데이터 용 1개의 shared_storage 볼륨

Red Hat Gluster Storage 클러스터에는 최대 1개의 지역 복제 볼륨이 포함될 수 있습니다.

Red Hat은 추가적으로 각 서버에 하나 이상의 로컬 핫 스페어 드라이브를 제공할 것을 권장합니다.

3.5.2. RAID

RAID 구성 제한은 사용 중인 기술에 따라 다릅니다.

- SAS/SATA 7k 디스크는 RAID6로 지원됩니다 (최대 10+2)

SAS 10k 및 15k 디스크는 다음으로 지원됩니다.

- RAID10

- RAID5 (최대 7+1)

- RAID6 (최대 10+2)

RAID 카드는 FBWC (Flash Backed Write Cache)를 사용해야 합니다.

3.5.3. JBOD

JBOD 구성에는 아키텍처 리뷰가 필요합니다. 자세한 사항은 Red Hat 담당자에게 문의하십시오.

3.5.4. 볼륨 유형

Red Hat Hyperconverged Infrastructure(RHHI)는 Replicated 또는 Arbitrated Replicated 볼륨 유형만 지원합니다.

Arbitrated Replicated 볼륨 유형은 다음의 추가 제한을 수행합니다.

- Arbitrated Replicated 볼륨은 처음 세 개의 노드에서만 지원됩니다.

-

Arbitrated Replicated 볼륨은

replica 3 arbiter 1구성을 사용해야 합니다. Arbiter 브릭은 파일 데이터를 저장하지 않습니다. 파일 이름, 구조 및 메타데이터만 저장합니다.

이는 3방향 Replicated 볼륨이 동일한 수준의 일관성을 구현하기 위해 스토리지 공간의 약 75%를 3방향 Arbitrated Replicated 볼륨에서 필요로 한다는 것을 의미합니다.

그러나 Arbiter 브릭은 메타데이터만 저장하므로 3방향 Arbitrated Replicated 볼륨은 2방향 Replicated 볼륨의 가용성만 제공합니다.

자세한 내용은 Red Hat Gluster Storage 3.2 관리 가이드: https://access.redhat.com/documentation/en-us/red_hat_gluster_storage/3.2/html-single/administration_guide/#Creating_Arbitrated_Replicated_Volumes를 참조하십시오.

3.6. 지원 제한

- 하나의 Arbitrated Replicated 볼륨은 Red Hat Hyperconverged Infrastructurer(RHHI)의 초기 배포 일부로 지원됩니다. 이 Arbitrated Replicated 볼륨 확장은 지원되지 않습니다. Arbitrated Replicated 볼륨 추가도 지원되지 않습니다.

-

Arbitrated Replicated 볼륨은 현재

replica 3 arbiter 1구성에서만 지원됩니다.

이러한 볼륨에 대한 자세한 내용은 Red Hat Gluster Storage 관리 가이드를 참조하십시오.

3.7. 재해 복구

Red Hat은 재해 복구 솔루션을 설정할 것을 강력히 권장합니다. 재해 복구 솔루션으로 지역 복제를 구성하는 방법에 대한 자세한 내용은 Red Hat Hyperconverged Infrastructure 유지관리를 참조하십시오. https://access.redhat.com/documentation/en-us/red_hat_hyperconverged_infrastructure/1.0/html/maintaining_red_hat_hyperconverged_infrastructure/configure_disaster_recovery_using_geo_replication

지역 복제를 구성하는 동안 다음의 지원 제한 사항에 유의하십시오.

- Red Hat Hyperconverged Infrastructure(RHHI)는 하나의 지역 복제 볼륨만 지원합니다. Red Hat은 가상 머신의 데이터를 저장하는 볼륨 백업을 권장합니다.

- 지역 복제의 소스 및 대상 볼륨은 Red Hat Virtualization Manager의 다른 인스턴스에서 관리해야 합니다.

II 부. 배포

4장. 배포 워크플로우

Red Hat Hyperconverged Infrastructure(RHHI) 배포의 워크플로우는 다음과 같습니다.

- 계획한 배포가 3장. 지원 요구 사항의 내용을 충족하는지 확인합니다.

- 가상 호스트로 작동할 5장. 호스트 물리 머신 설치를 실행합니다.

- 6장. 공개 키 기반 SSH 인증 구성에서 호스트의 자동화된 구성을 사용합니다 .

- Cockpit UI를 사용하여 호스트에 7장. Cockpit UI를 사용하여 호스트 엔진의 Red Hat Gluster Storage 구성을 실행합니다.

- Cockpit UI를 사용하여 8장. Cockpit UI를 사용하여 호스트 엔진 배포를 실행합니다.

- Red Hat Virtualization 관리 UI를 사용하여 Red Hat Gluster Storage 노드에서 9장. Red Hat Gluster Storage를 Red Hat Virtualization 스토리지 도메인으로 설정을 실행합니다.

5장. 호스트 물리 머신 설치

세 개의 물리 머신에 Red Hat Virtualization Host 4.1을 설치합니다. 가상화 호스트 설치에 대한 자세한 내용은 다음 섹션을 참조하십시오. https://access.redhat.com/documentation/en/red-hat-virtualization/4.1/paged/installation-guide/chapter-6-red-hat-virtualization-hosts.

6장. 공개 키 기반 SSH 인증 구성

첫 번째 가상 호스트에서 세 개의 모든 가상화 호스트에 root 사용자의 공개 키 인증 기반 SSH를 구성합니다.

백엔드 관리 네트워크와 연결된 IP 주소 또는 호스트 이름을 사용하는지 확인합니다.

자세한 내용은 Red Hat Enterprise Linux 7 설치 가이드를 참조하십시오. https://access.redhat.com/documentation/en-US/Red_Hat_Enterprise_Linux/7/html/System_Administrators_Guide/s1-ssh-configuration.html#s2-ssh-configuration-keypairs.

7장. Cockpit UI를 사용하여 호스트 엔진의 Red Hat Gluster Storage 구성

이 배포 프로세스의 일부로 지정된 디스크에 파티션 또는 레이블이 없는지 확인합니다.

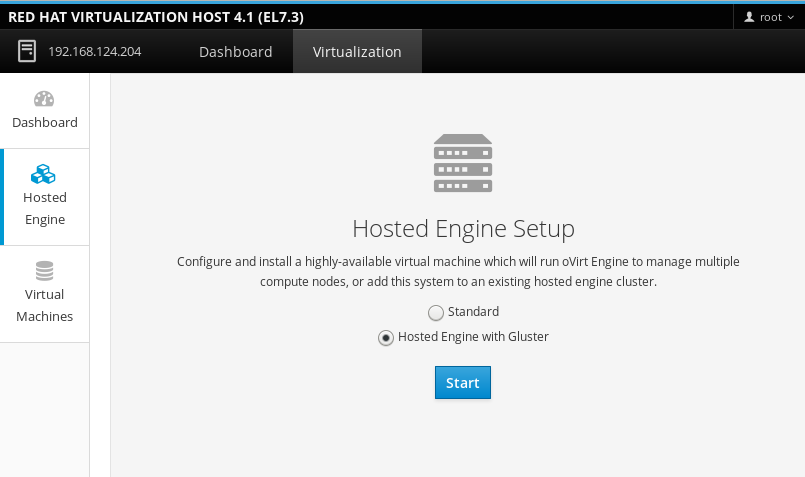

Cockpit UI에 로그인

첫 번째 가상화 호스트의 Cockpit 관리 인터페이스(예: https://node1.example.com:9090/)을 브라우저에서 열고 A. 호스트 물리 머신 설치에서 만든 인증 정보를 사용하여 로그인합니다.

배포 마법사 시작

가상화 > 호스트 엔진을 클릭하고 Gluster가 포함된 호스트 엔진을 선택한 다음 시작을 클릭하면 배포 마법사가 나타납니다.

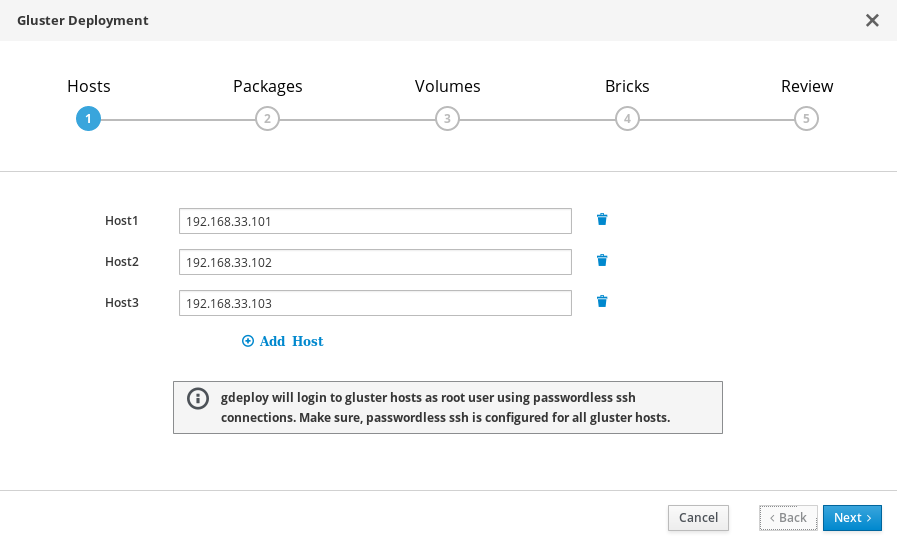

배포 마법사: 스토리지 호스트 지정

세 개의 가상화 호스트의 백엔드 Gluster 네트워크 주소 (관리 네트워크 주소가 아님)를 지정합니다. gdeploy 및 호스트 엔진을 실행할 호스트이므로 키 쌍을 사용하여 SSH 연결이 가능한 가상화 호스트가 먼저 나열되어야 합니다.

참고Arbitrated Replicated 볼륨을 만들려면 이 화면에서 Arbiter 브릭을 Host3로 사용하여 호스트를 지정하도록 합니다.

다음을 클릭합니다.

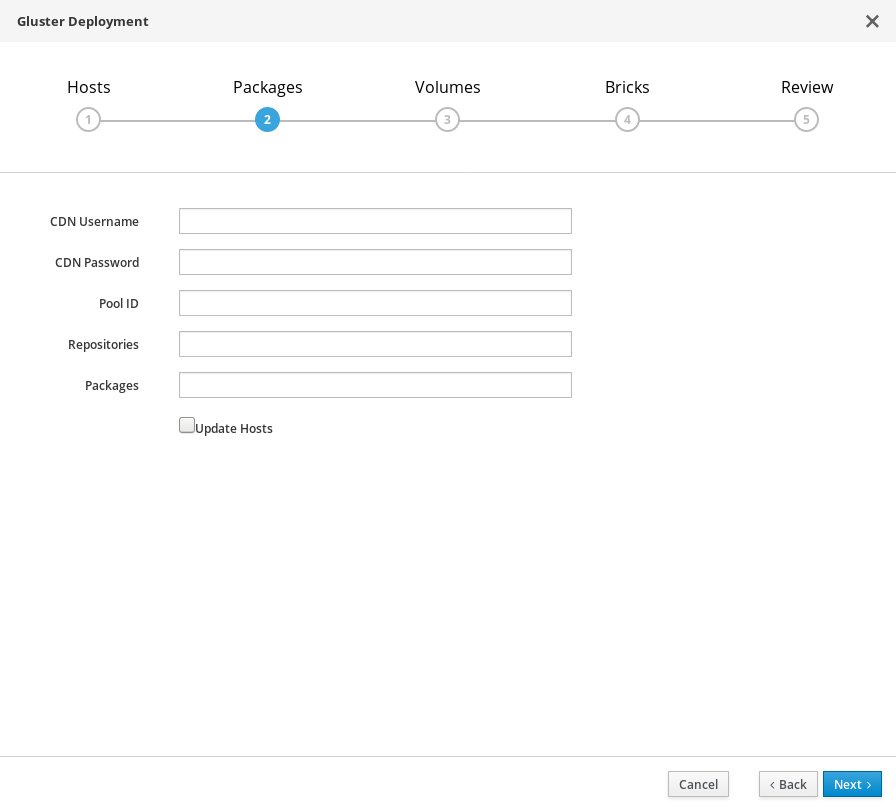

배포 마법사: 패키지 지정

패키지를 설치할 필요가 없습니다. 이러한 필드에서 값을 삭제하고 상자를 선택 해제합니다.

다음을 클릭합니다.

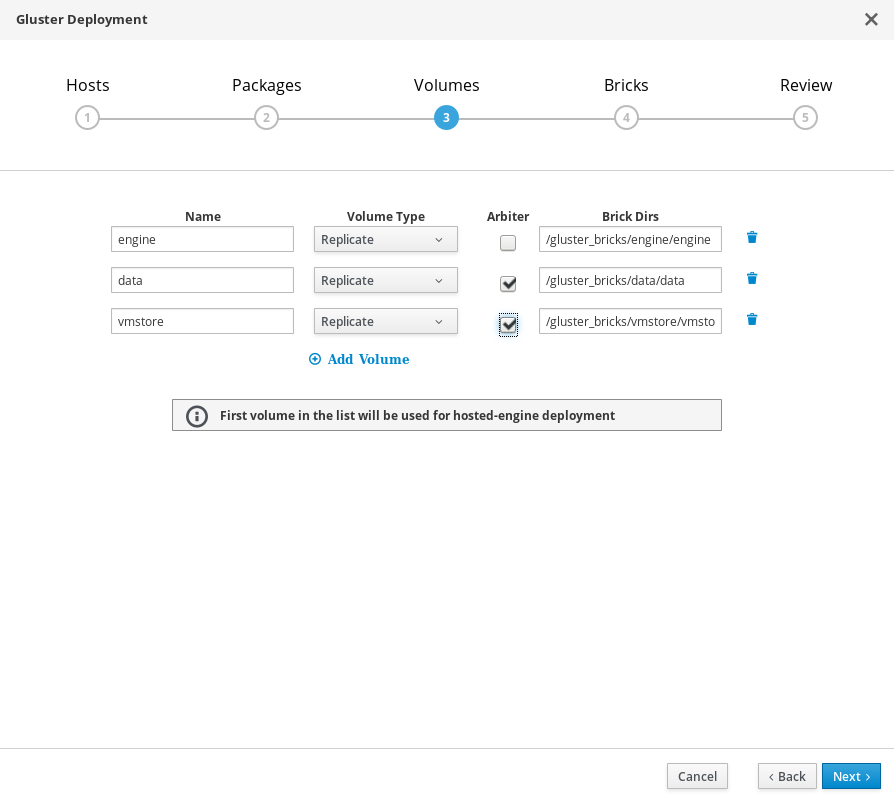

배포 마법사: 볼륨 지정

생성할 볼륨을 지정합니다.

- 이름

- 생성할 볼륨의 이름을 지정합니다.

- 볼륨 유형

- Replicate 볼륨 유형을 지정합니다. Replicate 볼륨만 이 릴리스에 지원됩니다.

- Arbiter

- Arbiter 브릭을 사용하여 볼륨을 생성할지 여부를 지정합니다. 이 상자를 선택하면 세 번째 디스크는 메타데이터만 저장됩니다.

- 브릭 디렉토리

- 이 볼륨의 브릭이 포함되어 있는 디렉토리입니다.

기본값은 대부분의 설치에 적용됩니다.

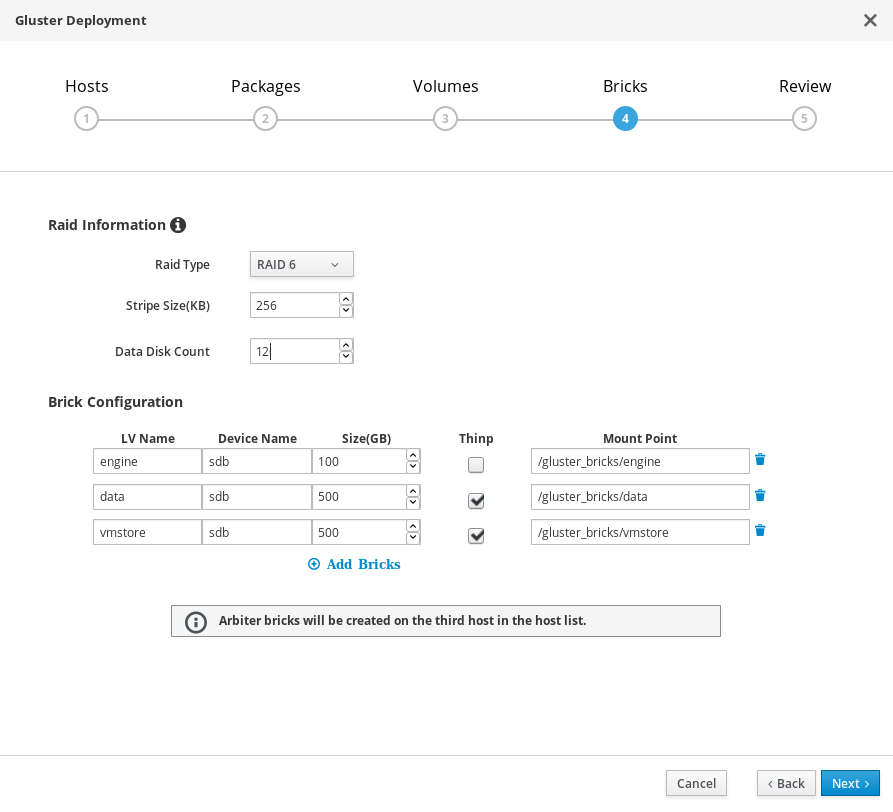

배포 마법사: 브릭 지정

생성할 브릭을 지정합니다.

- LV 이름

- 생성할 논리 볼륨의 이름을 지정합니다.

- 장치

- 사용할 로우(raw) 장치를 지정합니다. Red Hat은 파티션 설정되지 않은 장치를 권장합니다.

- 크기

- 생성할 논리 볼륨의 크기(GB)를 지정합니다. 단위가 아닌 숫자만 입력하십시오.

- 마운트 지점

- 논리 볼륨의 마운트 지점을 지정합니다. 마법사의 이전 페이지에서 지정한 브릭 디렉토리와 일치해야 합니다.

- Thinp

- 볼륨을 씬 프로비저닝으로 수행할지 여부를 지정합니다. 씩 프로비저닝은 engine 볼륨에 권장됩니다.

- RAID

- 사용할 RAID 구성을 지정합니다. 호스트의 RAID 구성과 일치해야 합니다. 지원되는 값은 raid5, raid6, raid10 및 jbod입니다.

- 스트라이프 크기

- RAID 스트라이프 크기(KB)를 지정합니다. 단위가 아닌 숫자를 입력하십시오. JBOD 구성에서는 무시할 수 있습니다.

- 디스크 수

- RAID 볼륨에서 데이터 디스크의 수를 지정합니다. JBOD 구성에서는 무시할 수 있습니다.

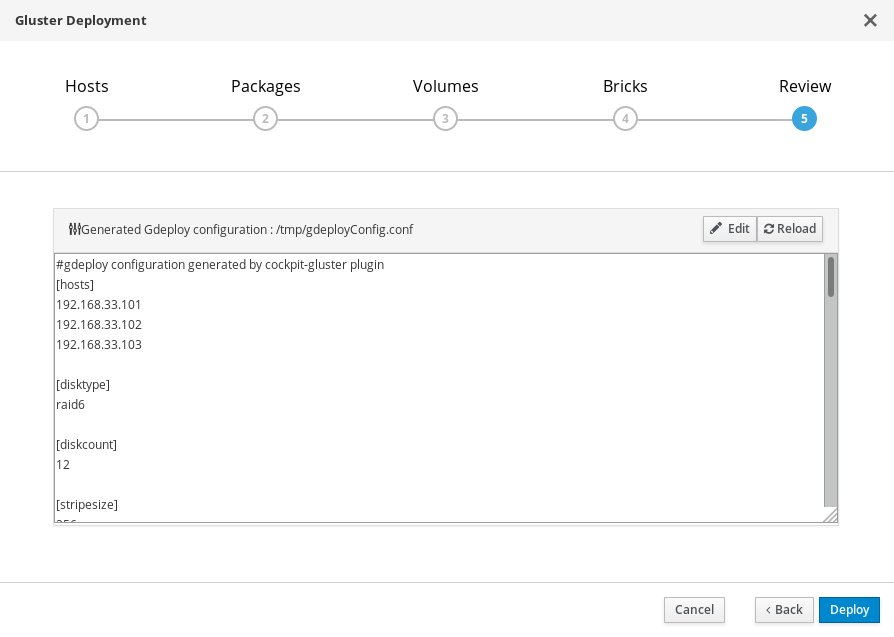

배포 마법사: 구성 검토 및 편집

- 편집을 클릭하여 생성된 gdeployConfig.conf 파일 편집을 시작합니다.

(선택 사항) Transport Layer Security(TLS/SSL)를 구성합니다.

배포 도중 또는 배포 후에 구성할 수 있습니다. 배포의 일부로 TLS/SSL 암호화를 구성하려는 경우 다음 섹션 중 하나를 참조하십시오.

구성 파일을 검토합니다.

구성 세부 사항에 만족하면 저장을 클릭한 다음 배포를 클릭합니다.

배포가 완료될 때까지 대기합니다.

생성된 구성 파일을 사용하여 gdeploy 프로세스가 실행될 때 텍스트 필드에서 배포 프로세스를 볼 수 있습니다.

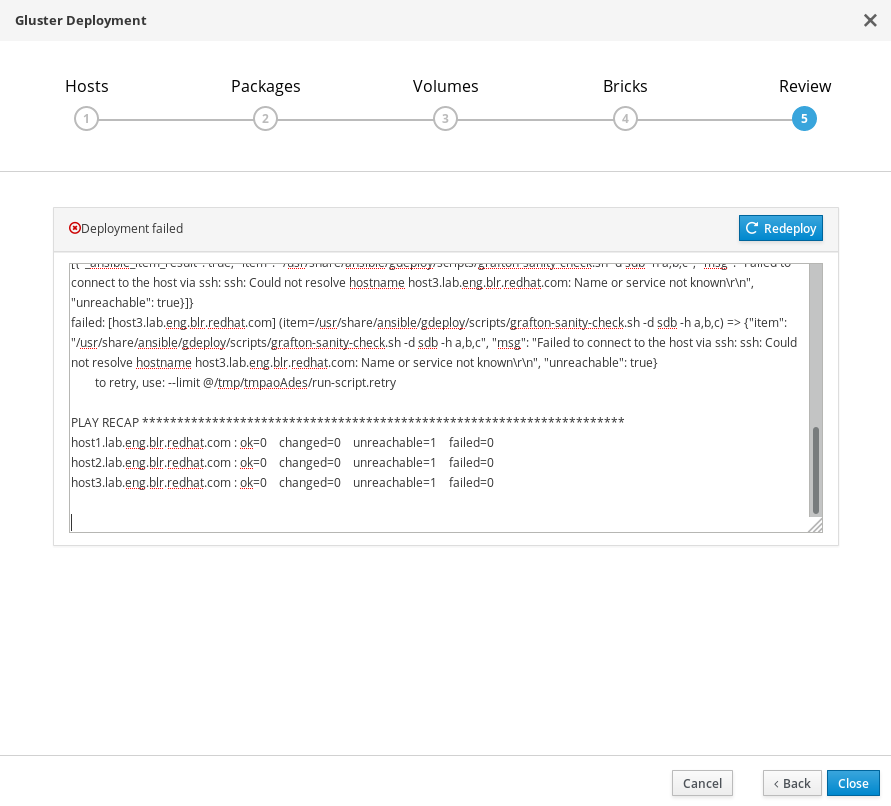

배포 실패의 경우 다음을 수행합니다.

배포가 실패하면 재배포 버튼을 클릭합니다. 배포를 재시도하기 전에 설정 검토 및 편집 탭으로 이동하여 생성된 구성 파일의 문제를 수정할 수 있습니다.

다시 배포하기 전에 이전 배포를 정리해야 할 수 있습니다. 11장. 자동화된 Red Hat Gluster Storage 배포 오류 정리 에 있는 단계에 따라 정리하십시오.

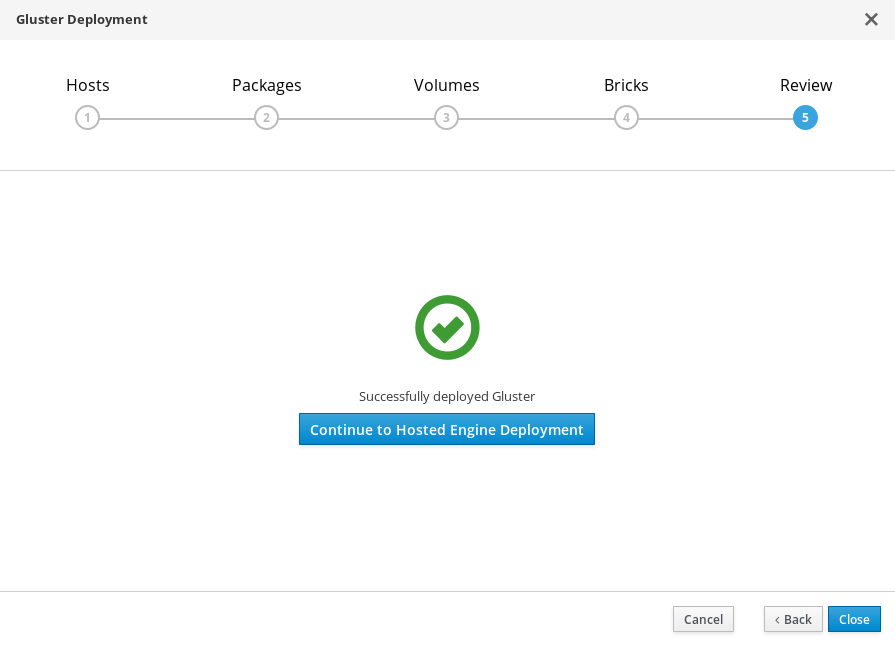

배포 스크립트가 완료되고 글러스터가 성공적으로 배포되었습니다라는 메시지가 표시됩니다.

8장. Cockpit UI를 사용하여 호스트 엔진 배포

이 섹션에서는 Cockpit UI를 사용하여 호스트 엔진을 배포하는 방법에 대해 설명합니다. 이 프로세스를 따르면 배포 시 첫 번째 물리 머신에서 가상 머신으로 실행되는 Red Hat Virtualization Manager가 배포됩니다. 또한 세 개의 물리 머신으로 구성된 기본 클러스터를 구성하며 클러스터의 각 머신에 Red Hat Gluster Storage 기능 및 virtual-host tuned 성능 프로파일을 사용할 수 있습니다.

호스트 엔진 배포 마법사로 이동합니다.

7장. Cockpit UI를 사용하여 호스트 엔진의 Red Hat Gluster Storage 구성을(를) 완료한 후 호스트 엔진 배포 계속 진행하기를 클릭하여 마법사로 이동합니다.

설치에 동의합니다.

Continuing will configure this host for serving as hypervisor and create a VM where you have to install the engine afterwards. Are you sure you want to continue?

표시된 필드에 예를 입력합니다. 다음을 클릭하고 환경이 설정될 때 까지 기다리십시오.

메시지가 표시되면 배포 질문에 답변합니다.

호스트 엔진 배포 마법사 메시지에 응답하여 호스트 엔진을 설치하고 구성합니다. Ctrl+D를 눌러 언제든지 프로세스를 중지할 수 있습니다.

표 8.1. 셀프 호스트 엔진 배포 마법사 프롬프트

메시지 텍스트 동작 Do you wish to install ovirt-engine-appliance rpm?

Yes를 입력합니다.

Do you want to configure this host and its cluster for gluster?

Yes를 입력합니다.

iptables was detected on your computer, do you wish setup to configure it?

No를 입력합니다.

Please indicate a pingable gateway IP address

프런트 엔드 게이트웨이 서버의 IP 주소를 입력합니다.

Please indicate a nic to set ovirtmgmt bridge on

프런트 엔드 관리 네트워크 주소를 입력합니다.

The following appliance have been found on your system: [1] The RHV-M Appliance image (OVA) - 4.1.20170328.1.el7ev [2] Directly select an OVA file. Please select an appliance

호스트 엔진 어플라이언스에 해당하는 숫자를 입력합니다(일반적으로 1).

Would you like to use cloud-init to customize the appliance on first boot

Yes를 입력합니다.

Would you like to generate on-fly a cloud-init ISO image (of no-cloud type) or do you have an existing one?

Generate를 입력합니다.

Please provide the FQDN you would like to use for the engine appliance. Note: This will be the FQDN of the engine VM you are now going to launch, it should not point to the base host or to any other existing machine. Engine VM FQDN:

호스트 엔진에 사용할 정규화된 도메인 이름을 입력합니다.

Please provide the domain name you would like to use for the engine appliance. Engine VM domain:

감지된 도메인 이름이 올바른지 확인합니다.

Automatically execute engine-setup on the engine appliance on first boot

Yes를 입력합니다.

Enter root password that will be used for the engine appliance

호스트 엔진에 원격으로 로그인하는 데 사용할 암호를 입력합니다.

Confirm appliance root password

호스트 엔진에 원격으로 로그인하는 데 사용할 암호를 다시 입력합니다.

Enter ssh public key for the root user that will be used for the engine appliance

이 필드를 비워 둡니다.

Do you want to enable ssh access for the root user

Yes를 입력합니다.

Please specify the memory size of the VM in MB

기본값을 사용합니다.

The following CPU types are supported by this host:

Please specify the CPU type to be used by the VM

기본값을 사용합니다.

Please specify the number of virtual CPUs for the VM

기본값을 사용합니다.

You may specify a unicast MAC address for the VM or accept a randomly generated default

호스트 엔진에 대해 지정한 정규화된 도메인 이름을 해결하는 MAC 주소를 입력합니다.

How should the engine VM network be configured

DHCP를 입력합니다.

Add lines for the appliance itself and for this host to /etc/hosts on the engine VM? (Note: ensuring that this host could resolve the engine VM hostname is still up to you)

No를 입력합니다.

Enter engine admin password (for the RHV UI)

Red Hat Virtualization Manager 관리자가 사용할 암호를 입력합니다.

Confirm engine admin password

Red Hat Virtualization Manager 관리자가 사용할 암호를 다시 입력합니다.

Please provide the name of the SMTP server through which we will send notifications

기본값을 사용합니다.

Please provide the TCP port number of the SMTP server

기본값을 사용합니다.

Please provide the email address from which notifications will be sent

기본값을 사용합니다.

Please provide a comma-separated list of email addresses which will get notifications

호스트 엔진에서 알림을 받을 이메일 주소를 입력합니다. 기본값(root@localhost)이 적합합니다.

설치 설정을 확인합니다.

Please confirm installation settings

설정 값을 검토하고 올바른지 확인합니다. 올바르다면 제공된 필드에 Yes를 입력하고 다음을 클릭합니다.

참고현재 프로세스에서 설정을 편집할 수 있는 방법은 없습니다. 설정 세부 정보가 올바르지 않다면 이 프로세스를 다시 시작하여 수정하거나 프로세스를 계속한 다음 배포하는 동안 수정해야 합니다.

배포가 완료될 때까지 대기합니다.

이 작업에는 다소 시간이 소요됩니다(약 30분).

배포가 완료되면 다음 메시지가 표시됩니다.

Hosted Engine Setup successfully completed!

이제 Red Hat Virtualization Manager에 로그인하여 설정을 완료할 수 있습니다.

배포가 완료되지 않으면 10장. 호스트 엔진 배포 오류 처리의 내용을 참조하십시오.

9장. Red Hat Gluster Storage를 Red Hat Virtualization 스토리지 도메인으로 설정

9.1. Gluster 트래픽의 논리 네트워크 생성

engine에 로그인합니다.

engine을 검색하고 8장. Cockpit UI를 사용하여 호스트 엔진 배포에서 설정한 관리 자격 증명을 사용하여 로그인합니다.

Gluster 트래픽의 논리 네트워크를 생성합니다.

- 네트워크 탭을 클릭한 다음 새로 만들기를 클릭합니다. 새 논리 네트워크 창이 나타납니다.

- 창에 있는 일반 탭에서 새 논리 네트워크에 이름을 입력하고 가상머신 네트워크 체크박스를 선택 해제합니다.

- 창에 있는 클러스터 탭에서 필수 체크박스를 선택 해제합니다.

- OK를 클릭하여 새 논리 네트워크를 만듭니다.

Gluster에 새 논리 네트워크를 활성화합니다

- 네트워크 탭을 클릭하고 새 논리 네트워크를 선택합니다.

- 클러스터 하위 탭을 클릭한 다음 네트워크 관리를 클릭합니다. 네트워크 관리 대화 상자가 나타납니다.

- 네트워크 관리 대화 상자에서 네트워크 마이그레이션 및 Gluster 네트워크 체크박스를 선택합니다.

- OK를 클릭하여 저장합니다.

Gluster 네트워크를 호스트에 연결합니다

- 호스트 탭을 클릭하고 호스트를 선택합니다.

- 네트워크 인터페이스 하위 탭을 클릭한 다음 호스트 네트워크 설정을 클릭합니다.

- 새로 만든 네트워크를 올바른 인터페이스에 끌어다 놓습니다.

- 호스트와 Engine 사이의 연결을 확인 체크박스를 선택했는지 확인합니다.

- 네트워크 설정 저장 체크박스를 선택했는지 확인합니다.

- OK를 클릭하여 저장합니다.

네트워크의 상태를 확인합니다.

호스트 탭을 클릭하고 해당 호스트를 선택합니다. 네트워크 인터페이스 하위 탭을 클릭하고 호스트의 네트워크 상태를 확인합니다.

네트워크 인터페이스가 "비동기화" 상태가 되거나 IPv4 주소가 없는 경우 해당 호스트의 관리 드롭 다운 메뉴에서 기능 새로고침을 클릭합니다.

9.2. 마스터 스토리지 도메인 생성

- 스토리지 탭을 클릭한 다음 새 도메인을 클릭합니다.

- GlusterFS를 스토리지 유형으로 선택하고 도메인의 이름을 입력합니다.

관리 Gluster 볼륨 사용 옵션을 선택합니다.

클러스터에서 사용 가능한 볼륨 목록이 표시됩니다.

vmstore 볼륨을 선택하고 다음을 마운트 옵션에 추가합니다.

backup-volfile-servers=server2:server3

- OK를 클릭하여 저장합니다.

호스트 엔진 스토리지 도메인은 마스터 스토리지 도메인 생성 후 자동으로 가져오기됩니다.

호스트 엔진 가상 머신 및 스토리지 도메인을 사용할 수 있게 될 때까지 기다린 후 다른 작업을 계속 진행합니다. 이렇게 하면 호스트 엔진 탭을 사용할 수 있게 됩니다.

9.3. 나머지 가상화 호스트를 호스트 엔진에 추가

다른 각각의 호스트의 Red Hat Virtualization Manager에서 다음 단계를 따릅니다.

- 호스트 탭을 클릭한 다음 새로 만들기를 클릭하여 새 호스트 대화 상자를 엽니다.

- 새 호스트의 이름, 주소 및 암호를 입력합니다.

- 방화벽 규칙을 이미 gdeploy에서 설정하였으므로 자동으로 호스트 방화벽 설정 체크박스를 선택 해제합니다.

- 새 호스트의 호스트 엔진 탭에서 호스트 엔진 배포 작업 선택의 값을 배포로 설정합니다.

- 배포를 클릭합니다.

Gluster 네트워크를 호스트에 연결합니다

- 호스트 탭을 클릭하고 호스트를 선택합니다.

- 네트워크 인터페이스 하위 탭을 클릭한 다음 호스트 네트워크 설정을 클릭합니다.

- 새로 만든 네트워크를 올바른 인터페이스에 끌어다 놓습니다.

- 호스트와 Engine 사이의 연결을 확인 체크박스를 선택했는지 확인합니다.

- 네트워크 설정 저장 체크박스를 선택했는지 확인합니다.

- OK를 클릭하여 저장합니다.

네트워크의 상태를 확인합니다.

호스트 탭을 클릭하고 해당 호스트를 선택합니다. 네트워크 인터페이스 하위 탭을 클릭하고 호스트의 네트워크 상태를 확인합니다.

네트워크 인터페이스가 "비동기화" 상태가 되거나 IPv4 주소가 없는 경우 해당 호스트의 관리 드롭 다운 메뉴에서 기능 새로고침을 클릭합니다.

자세한 내용은 Red Hat Virtualization 4.1 셀프 호스트 엔진 가이드를 참조하십시오. https://access.redhat.com/documentation/en/red-hat-virtualization/4.1/paged/self-hosted-engine-guide/chapter-7-installing-additional-hosts-to-a-self-hosted-environment

III 부. 문제 해결

10장. 호스트 엔진 배포 오류 처리

호스트 엔진을 배포하는 동안 오류가 발생하는 경우 배포가 일시 정지되며 다음과 같은 메시지가 표시됩니다.

Please check Engine VM configuration Make a selection from the options below: (1) Continue setup - Engine VM configuration has been fixed (2) Abort setup

오류 세부 사항이 빨간색으로 표시됩니다. 호스트 엔진에 로그인하여 오류를 수정한 후 설정을 계속할 수 있습니다. 설정 계속을 선택하기 전에 ovirt-engine 서비스를 먼저 중지하고 다시 시작하여 수정 사항을 적용해야 합니다.

11장. 자동화된 Red Hat Gluster Storage 배포 오류 정리

- 부록 B. gdeploy에 대한 정리 설정 파일의 예 에서 volume_cleanup.conf 파일을 기반으로 volume_cleanup.conf 파일을 만듭니다.

volume_cleanup.conf 파일을 사용하여 gdeploy를 실행합니다.

# gdeploy -c volume_cleanup.conf

- 부록 B. gdeploy에 대한 정리 설정 파일의 예 에서 lv_cleanup.conf 파일을 기반으로 lv_cleanup.conf 파일을 만듭니다.

lv_cleanup.conf 파일을 사용하여 gdeploy를 실행합니다.

# gdeploy -c lv_cleanup.conf

모든 호스트에서 마운트 설정을 확인합니다.

모든 호스트에서 /etc/fstab 파일을 확인하고 자동으로 생성된 브릭의 XFS 마운트에 해당하는 모든 행을 제거합니다.

IV 부. 확인

12장. 배포 확인

배포가 완료되면 Red Hat Virtualization Manager를 사용하여 배포 상태를 확인합니다.

가상 머신을 만들어 배포가 예상대로 작동하는지 확인합니다. 자세한 내용은 Red Hat Virtualization 가상 머신 관리 가이드를 참조하십시오. https://access.redhat.com/documentation/en-us/red_hat_virtualization/4.1/html/virtual_machine_management_guide/.

V 부. 참고 자료

부록 A. 배포하는 동안 암호화 설정

A.1. 인증 기관에서 서명된 인증서를 사용하여 배포하는 동안 TLS/SSL 설정

A.1.1. 작업을 시작하기 전에 확인할 사항

작업을 시작하기 전에 인증 기관에서 서명한 적합한 인증서가 있는지 확인합니다. 인증서 취득 방법은 본 문서에서 다루지 않습니다.

A.1.2. CA 서명 인증서를 사용하여 TLS/SSL 암호화 설정

다음 파일이 모든 노드의 해당 위치에 있는지 확인합니다.

- /etc/ssl/glusterfs.key

- 노드의 개인 키입니다.

- /etc/ssl/glusterfs.pem

- 노드의 인증서가 되는 인증 기관에서 서명한 인증서입니다.

- /etc/ssl/glusterfs.ca

- 인증 기관의 인증서입니다. 자체 서명 설정의 경우 이 파일에 모든 노드에 연결된 인증서가 포함됩니다.

관리 암호화를 활성화합니다.

각 노드에서 /var/lib/glusterd/secure-access 파일을 만듭니다.

# touch /var/lib/glusterd/secure-access

암호화를 설정합니다.

다음 행을 7장. Cockpit UI를 사용하여 호스트 엔진의 Red Hat Gluster Storage 구성의 일부로 생성된 설정 파일에 나열된 각 볼륨에 추가합니다. 배포 프로세스의 일부로 CA 서명 인증서를 사용하여 Gluster 볼륨 간에 TLS/SSL 기반 암호화를 만들고 구성합니다.

key=client.ssl,server.ssl,auth.ssl-allow value=on,on,"host1;host2;host3"

편집 후에는 생성된 파일을 저장해야 합니다.

A.2. 자체 서명 인증서를 사용하여 배포하는 동안 TLS/SSL 암호화 설정

다음 행을 7장. Cockpit UI를 사용하여 호스트 엔진의 Red Hat Gluster Storage 구성에서 생성된 설정 파일에 추가하여 배포 프로세스의 일부로 자체 서명 인증서를 사용하여 Gluster 볼륨 간에 TLS/SSL 기반 암호화를 만들고 구성합니다. gdeploy에서 생성한 인증서의 유효 기간은 1년입니다.

첫 번째 볼륨 설정에서 enable_ssl 및 ssl_clients 매개 변수 및 값을 지정하는 행을 추가합니다.

[volume1] enable_ssl=yes ssl_clients=<Gluster_Network_IP1>,<Gluster_Network_IP2>,<Gluster_Network_IP3>

후속 볼륨 설정에서 다음 행을 추가하여 client.ssl, server.ssl 및 auth.ssl-allow 매개 변수의 값을 정의합니다.

[volumeX] key=client.ssl,server.ssl,auth.ssl-allow value=on,on,"<Gluster_Network_IP1>;<Gluster_Network_IP2>;<Gluster_Network_IP3>"

부록 B. gdeploy에 대한 정리 설정 파일의 예

배포가 실패하는 경우 배포를 다시 시도하기 전에 이전 배포를 정리해야 합니다. 다음 두 개의 예제 파일을 gdeploy로 실행하여 배포를 다시 시도할 수 있도록 이전에 실패한 배포를 정리할 수 있습니다.

volume_cleanup.conf

[hosts] <Gluster_Network_NodeA> <Gluster_Network_NodeB> <Gluster_Network_NodeC> [volume1] action=delete volname=engine [volume2] action=delete volname=vmstore [volume3] action=delete volname=data [peer] action=detach

lv_cleanup.conf

[hosts] <Gluster_Network_NodeA> <Gluster_Network_NodeB> <Gluster_Network_NodeC> [backend-reset] pvs=sdb,sdc unmount=yes

부록 C. 생성된 gdeploy 설정 파일에 대한 이해

Gdeploy는 설정 파일을 기반으로 Red Hat Gluster Storage를 사용하여 하나 이상의 머신을 자동으로 프로비저닝합니다.

Cockpit UI는 Red Hat Hyperconverged Infrastructure의 기본 수준 배포 수행에 적합한 gdeploy 설정 파일을 사용자가 생성할 수 있는 마법사를 제공합니다.

이 섹션에서는 Cockpit UI에 다음의 설정 세부 사항이 지정된 경우 생성되는 gdeploy 설정 파일에 대해 설명합니다.

- IP 주소가 192.168.0.101, 192.168.0.102, 192.168.0.103인 3개의 호스트

- 추가 패키지 또는 리포지터리가 없음

- 모든 볼륨에 대한 Arbiter 설정

- 스트라이프 크기가 256KB인 RAID 6로 구성된 12개의 브릭

다음 섹션이 포함된 gdeploy 설정 파일이 생성됩니다.

여기에 정의된 섹션에 대한 자세한 내용은 Red Hat Gluster Storage 관리 가이드를 참조하십시오. https://access.redhat.com/documentation/en-us/red_hat_gluster_storage/3.2/html/administration_guide/chap-red_hat_storage_volumes#chap-Red_Hat_Storage_Volumes-gdeploy_configfile.

[hosts] 섹션

[hosts] 192.168.0.101 192.168.0.102 192.168.0.103

[hosts] 섹션에서는 이 설정 파일에 따라 구성되는 세 개의 물리 머신의 IP 주소를 정의합니다.

[script1] 섹션

[script1] action=execute ignore_script_errors=no file=/usr/share/ansible/gdeploy/scripts/grafton-sanity-check.sh -d sdb -h 192.168.0.101,192.168.0.102,192.168.0.103

[script1] 섹션에서는 오류 없이 gdeploy를 실행하도록 모든 호스트가 올바르게 설정되었는지 확인하기 위해 실행할 스크립트를 지정합니다.

기본 스토리지 설정

[disktype] raid6 [diskcount] 12 [stripesize] 256

[disktype] 섹션에서는 모든 호스트에 대한 기본 스토리지의 하드웨어 설정을 지정합니다.

[diskcount] 섹션은 RAID 스토리지에서 디스크의 수를 지정합니다. JBOD 구성에서는 이 작업을 생략할 수 있습니다.

[stripesize] 섹션에서는 RAID 스토리지 스트라이프 크기를 킬로바이트로 지정합니다. JBOD 구성에서는 이 작업을 생략할 수 있습니다.

NTPD 활성화 및 재시작

[service1] action=enable service=ntpd [service2] action=restart service=ntpd

이러한 서비스 섹션은 모든 호스트에서 Network Time Protocol Daemon(NTPD)를 활성화하고 재시작합니다.

모든 호스트에서 물리적 볼륨 생성

[pv1] action=create devices=sdb ignore_pv_errors=no

[pv1] 섹션은 모든 호스트의 sdb 장치에서 물리적 볼륨을 생성합니다.

모든 호스트에서 볼륨 그룹 생성

[vg1] action=create vgname=gluster_vg_sdb pvname=sdb ignore_vg_errors=no

[vg1] 섹션은 모든 호스트에서 이전에 생성된 물리적 볼륨에 볼륨 그룹을 생성합니다.

논리 볼륨 씬 풀 생성

[lv1:{192.168.0.101,192.168.0.102}]

action=create

poolname=gluster_thinpool_sdb

ignore_lv_errors=no

vgname=gluster_vg_sdb

lvtype=thinpool

poolmetadatasize=16GB

size=1000GB

[lv2:192.168.0.103]

action=create

poolname=gluster_thinpool_sdb

ignore_lv_errors=no

vgname=gluster_vg_sdb

lvtype=thinpool

poolmetadatasize=16GB

size=20GB

[lv1:*] 섹션에서는 처음 두 개의 호스트에 메타 데이터 풀 크기를 16GB로 지정하여 1000GB의 씬 풀을 생성합니다.

[lv2:*] 섹션에서는 세 번째 호스트에 메타 데이터 풀 크기를 16GB로 지정하여 20GB의 씬 풀을 생성합니다. 이는 Arbiter 브릭에 사용되는 논리 볼륨입니다.

chunksize 변수도 사용할 수 있지만 주의하여 사용해야 합니다. chunksize는 스냅샷, 캐시 풀 및 씬 풀에 사용되는 청크의 크기를 정의합니다. 이 값은 기본적으로 킬로바이트로 지정됩니다. RAID 5 및 6 볼륨의 경우 gdeploy에서 스트라이프 크기 및 디스크 개수를 곱하여 기본 청크 크기를 계산합니다. RAID 10의 경우 기본 청크 크기는 256KB입니다.

Red Hat은 최소한의 기본 청크 크기 사용을 권장합니다. 청크 크기가 너무 작고 볼륨에 메타데이터에 대한 공간이 부족한 경우 볼륨에서 데이터를 생성할 수 없습니다. Red Hat은 논리 볼륨을 모니터링하여 메타데이터 볼륨이 완전히 채워지기 전에 논리 볼륨이 확장되었는지 또는 더 많은 스토리지가 생성되었는지 확인할 것을 권장합니다.

기본 엔진 스토리지 생성

[lv3:{192.168.0.101,192.168.0.102}]

action=create

lvname=gluster_lv_engine

ignore_lv_errors=no

vgname=gluster_vg_sdb

mount=/gluster_bricks/engine

size=100GB

lvtype=thick

[lv4:192.168.0.103]

action=create

lvname=gluster_lv_engine

ignore_lv_errors=no

vgname=gluster_vg_sdb

mount=/gluster_bricks/engine

size=10GB

lvtype=thick

[lv3:*] 섹션에서는 처음 두 개의 호스트에 gluster_lv_engine이라는 100GB의 씩 프로비저닝 논리 볼륨을 생성합니다. 이 볼륨은 /gluster_bricks/engine에 마운트하도록 설정되어 있습니다.

[lv4:*] 섹션은 세 번째 호스트에 있는 엔진에 10GB의 씩 프로비저닝 논리 볼륨을 생성합니다. 이 볼륨은 /gluster_bricks/engine에 마운트하도록 설정되어 있습니다.

기본 데이터 및 가상 머신 부팅 디스크 스토리지 생성

[lv5:{192.168.0.101,192.168.0.102}]

action=create

lvname=gluster_lv_data

ignore_lv_errors=no

vgname=gluster_vg_sdb

mount=/gluster_bricks/data

lvtype=thinlv

poolname=gluster_thinpool_sdb

virtualsize=500GB

[lv6:192.168.0.103]

action=create

lvname=gluster_lv_data

ignore_lv_errors=no

vgname=gluster_vg_sdb

mount=/gluster_bricks/data

lvtype=thinlv

poolname=gluster_thinpool_sdb

virtualsize=10GB

[lv7:{192.168.0.101,192.168.0.102}]

action=create

lvname=gluster_lv_vmstore

ignore_lv_errors=no

vgname=gluster_vg_sdb

mount=/gluster_bricks/vmstore

lvtype=thinlv

poolname=gluster_thinpool_sdb

virtualsize=500GB

[lv8:192.168.0.103]

action=create

lvname=gluster_lv_vmstore

ignore_lv_errors=no

vgname=gluster_vg_sdb

mount=/gluster_bricks/vmstore

lvtype=thinlv

poolname=gluster_thinpool_sdb

virtualsize=10GB

[lv5:*] 및 [lv7:*] 섹션은 처음 두 개의 호스트에서 데이터 및 vmstore 볼륨의 브릭으로 500GB의 논리 볼륨을 생성합니다.

[lv6:*] 및 [lv8:*] 섹션은 세 번째 호스트에서 데이터 및 vmstore 볼륨의 Arbiter 브릭으로 10GB의 논리 볼륨을 생성합니다.

데이터 브릭은 /gluster_bricks/data에서 마운트하도록 설정되어 있으며 vmstore 브릭은 /gluster_bricks/vmstore에서 마운트하도록 설정되어 있습니다.

SELinux 파일 시스템 레이블 구성

[selinux] yes

[selinux] 섹션은 생성된 스토리지를 Gluster 스토리지에 적합한 SELinux 파일 시스템 레이블로 설정해야 하는지 여부를 지정합니다.

glusterd 시작

[service3] action=start service=glusterd slice_setup=yes

[service3] 섹션에서는 glusterd 서비스를 시작하고 glusterd에서 모든 시스템 리소스를 사용할 수 없도록 제어 그룹을 구성합니다. 자세한 내용은 Red Hat Enterprise Linux 리소스 관리 가이드를 참조하십시오. https://access.redhat.com/documentation/en-US/Red_Hat_Enterprise_Linux/7/html/Resource_Management_Guide/index.html.

방화벽 설정

[firewalld] action=add ports=111/tcp,2049/tcp,54321/tcp,5900/tcp,5900-6923/tcp,5666/tcp,16514/tcp services=glusterfs

[firewalld] 섹션에서는 Gluster 트래픽을 허용하는 데 필요한 포트를 엽니다.

Gluster 후크 비활성화

[script2] action=execute file=/usr/share/ansible/gdeploy/scripts/disable-gluster-hooks.sh

[script2] 섹션에서는 HCI (Hyper Converged Infrastructure) 로 중단할 수 있는 Gluster 후크를 비활성화합니다.

Gluster 볼륨 생성

[volume1] action=create volname=engine transport=tcp replica=yes replica_count=3 key=group,storage.owner-uid,storage.owner-gid,network.ping-timeout,performance.strict-o-direct,network.remote-dio,cluster.granular-entry-heal value=virt,36,36,30,on,off,enable brick_dirs=192.168.0.101:/gluster_bricks/engine/engine,192.168.0.102:/gluster_bricks/engine/engine,192.168.0.103:/gluster_bricks/engine/engine ignore_volume_errors=no arbiter_count=1 [volume2] action=create volname=data transport=tcp replica=yes replica_count=3 key=group,storage.owner-uid,storage.owner-gid,network.ping-timeout,performance.strict-o-direct,network.remote-dio,cluster.granular-entry-heal value=virt,36,36,30,on,off,enable brick_dirs=192.168.0.101:/gluster_bricks/data/data,192.168.0.102:/gluster_bricks/data/data,192.168.0.103:/gluster_bricks/data/data ignore_volume_errors=no arbiter_count=1 [volume3] action=create volname=vmstore transport=tcp replica=yes replica_count=3 key=group,storage.owner-uid,storage.owner-gid,network.ping-timeout,performance.strict-o-direct,network.remote-dio,cluster.granular-entry-heal value=virt,36,36,30,on,off,enable brick_dirs=192.168.0.101:/gluster_bricks/vmstore/vmstore,192.168.0.102:/gluster_bricks/vmstore/vmstore,192.168.0.103:/gluster_bricks/vmstore/vmstore ignore_volume_errors=no arbiter_count=1

[volume*] 섹션에서는 세 개의 Arbitrated Replicated의 Red Hat Gluster Storage 볼륨을 구성합니다(engine, data, vmstore). 세 번째 호스트의 각 볼륨에는 한 개의 Arbiter 브릭이 있습니다.

key 및 value 매개 변수는 다음 옵션을 설정하는데 사용됩니다.

-

group=virt -

storage.owner-uid=36 -

storage.owner-gid=36 -

network.ping-timeout=30 -

performance.strict-o-direct=on -

network.remote-dio=off -

cluster.granular-entry-heal=enable