보안 강화

Red Hat Enterprise Linux 9 시스템의 보안 강화

초록

보다 포괄적 수용을 위한 오픈 소스 용어 교체

Red Hat은 코드, 문서, 웹 속성에서 문제가 있는 용어를 교체하기 위해 최선을 다하고 있습니다. 먼저 마스터(master), 슬레이브(slave), 블랙리스트(blacklist), 화이트리스트(whitelist) 등 네 가지 용어를 교체하고 있습니다. 이러한 변경 작업은 작업 범위가 크므로 향후 여러 릴리스에 걸쳐 점차 구현할 예정입니다. 자세한 내용은 CTO Chris Wright의 메시지를 참조하십시오.

Red Hat 문서에 관한 피드백 제공

문서 개선을 위한 의견에 감사드립니다. 어떻게 개선할 수 있는지 알려주십시오.

특정 문구에 대한 의견 제출

- Multi-page HTML 형식으로 설명서를 보고 페이지가 완전히 로드된 후 오른쪽 상단 모서리에 피드백 버튼이 표시되는지 확인합니다.

- 커서를 사용하여 주석 처리할 텍스트 부분을 강조 표시합니다.

- 강조 표시된 텍스트 옆에 표시되는 피드백 추가 버튼을 클릭합니다.

- 의견을 추가하고 제출을 클릭합니다.

Jira를 통해 피드백 제출 (등록 필요)

- Jira 웹 사이트에 로그인합니다.

- 상단 탐색 모음에서 생성 을 클릭합니다.

- 요약 필드에 설명 제목을 입력합니다.

- 설명 필드에 개선을 위한 제안을 입력합니다. 문서의 관련 부분에 대한 링크를 포함합니다.

- 대화 상자 하단에서 생성 을 클릭합니다.

1장. 설치 중 RHEL 보안

Red Hat Enterprise Linux 설치를 시작하기 전에 이미 보안 대응이 시작됩니다. 처음부터 안전하게 시스템을 구성하면 나중에 추가 보안 설정을 더 쉽게 구현할 수 있습니다.

1.1. BIOS 및 UEFI 보안

BIOS(또는 이에 상응하는 BIOS) 및 부트 로더에 대한 암호 보호는 시스템에 대한 물리적 액세스 권한이 없는 사용자가 이동식 미디어를 사용하여 부팅하거나 단일 사용자 모드를 통해 root 권한을 얻는 것을 방지할 수 있습니다. 이러한 공격으로부터 보호하기 위해 수행해야 하는 보안 조치는 워크스테이션에 대한 정보의 민감도와 시스템의 위치에 따라 달라집니다.

예를 들어, 시스템이 무역 박람회에 사용되며 중요한 정보가 포함되지 않은 경우 이러한 공격을 방지하는 것이 중요하지 않을 수 있습니다. 그러나 회사 네트워크에 대해 암호화되지 않은 개인용 SSH 키가 있는 직원의 랩톱이 동일한 무역 박람회에서 그대로 유지되는 경우 회사 전체에 심각한 보안 침해가 발생할 수 있습니다.

반면에 권한이 있거나 신뢰할 수 있는 사람만 액세스할 수 있는 장소에 워크스테이션이 있는 경우 BIOS 또는 부트 로더 보안이 필요하지 않을 수 있습니다.

1.1.1. BIOS 암호

컴퓨터의 BIOS를 암호로 보호하는 두 가지 주요 이유는 다음과 같습니다.[1]:

- BIOS 설정 변경 방지

- 침입자가 BIOS에 액세스할 수 있는 경우 CD-ROM 또는 플래시 드라이브에서 부팅하도록 설정할 수 있습니다. 이를 통해 복구 모드 또는 단일 사용자 모드로 전환할 수 있으므로 시스템에서 임의의 프로세스를 시작하거나 중요한 데이터를 복사할 수 있습니다.

- 시스템 부팅 방지

- 일부 BIOS는 부팅 프로세스의 암호 보호를 허용합니다. 활성화되면 공격자는 BIOS가 부트 로더를 시작하기 전에 암호를 입력해야 합니다.

BIOS 암호를 설정하는 방법은 컴퓨터 제조업체마다 다르기 때문에 특정 지침은 컴퓨터 설명서를 참조하십시오.

BIOS 암호를 잊어버린 경우 마더보드의 점퍼를 사용하거나 CMOS 배터리의 연결을 해제하여 재설정할 수 있습니다. 따라서 가능한 경우 컴퓨터 케이스를 잠그는 것이 좋습니다. 그러나 CMOS 배터리의 연결을 해제하기 전에 컴퓨터 또는 마더보드에 대한 설명서를 참조하십시오.

1.1.2. 비BIOS 기반 시스템 보안

다른 시스템 및 아키텍처는 서로 다른 프로그램을 사용하여 x86 시스템의 BIOS와 거의 동일한 수준의 작업을 수행합니다. 예를 들어UEFI( Unified Extensible Firmware Interface ) 쉘이 있습니다.

BIOS와 같은 프로그램을 보호하는 암호에 대한 지침은 제조업체의 지침을 참조하십시오.

1.2. 디스크 파티션 설정

Red Hat은/boot, /, /home, /tmp, /var/tmp/ 디렉토리에 대해 별도의 파티션을 만드는 것을 권장합니다.

/boot-

이 파티션은 부팅 중에 시스템에서 읽은 첫 번째 파티션입니다. 시스템을 Red Hat Enterprise Linux 9로 부팅하는 데 사용되는 부트 로더 및 커널 이미지는 이 파티션에 저장됩니다. 이 파티션은 암호화해서는 안 됩니다. 이 파티션이

/에 포함되어 있고 해당 파티션을 암호화하거나 사용할 수 없게 되면 시스템을 부팅할 수 없습니다. /home-

사용자 데이터(

/home)가 별도의 파티션 대신/에 저장되어 파티션이 채워지면 운영 체제가 불안정해집니다. 또한 시스템을 Red Hat Enterprise Linux 9의 다음 버전으로 업그레이드할 때 데이터를/home파티션에 덮어쓰지 않으므로 업그레이드가 더 쉽습니다. 루트 파티션(/)이 손상되면 데이터가 영구적으로 손실될 수 있습니다. 별도의 파티션을 사용하면 데이터 손실을 조금 더 완화할 수 있습니다. 이 파티션을 빈번한 백업의 대상으로 지정할 수도 있습니다. /tmp및/var/tmp/-

/tmp및/var/tmp/디렉터리는 모두 장기간 저장하지 않아도 되는 데이터를 저장하는 데 사용됩니다. 그러나 이러한 디렉토리 중 하나에 많은 데이터가 범람하는 경우 모든 스토리지 공간을 소비할 수 있습니다. 이 경우 이러한 디렉토리가/내에 저장되면 시스템이 불안정해 충돌할 수 있습니다. 따라서 이러한 디렉터리를 해당 파티션으로 이동하는 것이 좋습니다.

설치 프로세스 중에 파티션을 암호화할 수 있는 옵션이 있습니다. 암호를 제공해야 합니다. 이 암호는 파티션의 데이터를 보호하는 데 사용되는 대량 암호화 키의 잠금을 해제하는 키 역할을 합니다.

1.3. 설치 프로세스 중에 네트워크 연결 제한

Red Hat Enterprise Linux 9를 설치할 때 설치 미디어는 특정 시간에 시스템의 스냅샷을 나타냅니다. 이로 인해 최신 보안 수정 사항이 최신 상태가 아닐 수 있으며 설치 미디어에서 제공한 시스템이 릴리스된 후에만 수정된 특정 문제에 취약해질 수 있습니다.

잠재적으로 취약한 운영 체제를 설치하는 경우 항상 가장 필요한 네트워크 영역으로만 노출을 제한합니다. 가장 안전한 선택은 "네트워크 없음" 영역으로, 설치 프로세스 중에 시스템의 연결이 끊어진 상태로 두는 것을 의미합니다. 인터넷 연결이 가장 위험한 경우에는 LAN 또는 인트라넷 연결만으로도 충분합니다. 최상의 보안 사례를 따르려면 네트워크에서 Red Hat Enterprise Linux 9를 설치하는 동안 리포지토리에서 가장 가까운 영역을 선택하십시오.

1.4. 필요한 최소 패키지 설치

컴퓨터에 있는 각 소프트웨어에 취약점이 있을 수 있으므로 사용할 패키지만 설치하는 것이 좋습니다. DVD 미디어에서 설치하는 경우 설치 중에 설치할 패키지를 정확하게 선택할 수 있습니다. 다른 패키지가 필요한 경우 나중에 시스템에 항상 추가할 수 있습니다.

1.5. 설치 후 절차

다음 단계는 Red Hat Enterprise Linux 9를 설치한 직후 수행해야 하는 보안 관련 절차입니다.

시스템을 업데이트합니다. root로 다음 명령을 입력합니다.

# dnf update방화벽 서비스

firewalld는 Red Hat Enterprise Linux 설치를 통해 자동으로 활성화되지만 Kickstart 구성에서는 명시적으로 비활성화할 수 있습니다. 이러한 경우 방화벽을 다시 활성화합니다.firewalld를 시작하려면 root로 다음 명령을 입력합니다.# systemctl start firewalld # systemctl enable firewalld

보안을 강화하려면 필요하지 않은 서비스를 비활성화합니다. 예를 들어 컴퓨터에 프린터가 설치되어 있지 않은 경우 다음 명령을 사용하여

cups서비스를 비활성화합니다.# systemctl disable cups활성 서비스를 검토하려면 다음 명령을 입력합니다.

$ systemctl list-units | grep service

2장. FIPS 모드에서 시스템 설치

FIPS(Federal Information Processing Standard) 140-3에서 요구하는 암호화 모듈 자체 점검을 활성화하려면 FIPS 모드에서 RHEL 9를 실행해야 합니다. FIPS 규정 준수를 목표로 하는 경우 FIPS 모드에서 설치를 시작하는 것이 좋습니다.

RHEL 9의 암호화 모듈은 FIPS 140-3 요구 사항에 대해 아직 인증되지 않았습니다.

2.1. 연방 정보 처리 표준 140 및 FIPS 모드

FIPS(Federal Information Processing Standards) 발행 140는 암호화 모듈의 품질을 보장하기 위해 NIST(National Institute of Standards and Technology)에서 개발한 일련의 컴퓨터 보안 표준입니다. FIPS 140 표준을 사용하면 암호화 도구가 알고리즘이 올바르게 구현됩니다. 런타임 암호화 알고리즘 및 무결성 자체 테스트는 시스템이 표준 요구 사항을 충족하는 암호화를 사용하도록 하는 몇 가지 메커니즘입니다.

RHEL 시스템이 FIPS 승인 알고리즘에서만 모든 암호화 키를 생성하고 사용하는지 확인하려면 RHEL을 FIPS 모드로 전환해야 합니다.

다음 방법 중 하나를 사용하여 FIPS 모드를 활성화할 수 있습니다.

- FIPS 모드에서 설치 시작

- 설치 후 FIPS 모드로 시스템 전환

FIPS 컴플라이언스를 사용하려면 FIPS 모드에서 설치를 시작합니다. 이렇게 하면 이미 배포된 시스템 변환과 관련된 결과 시스템의 규정 준수를 위한 암호화 주요 자료 재생성 및 재평가를 방지할 수 있습니다.

FIPS 호환 시스템을 작동하려면 FIPS 모드에서 모든 암호화 키 자료를 생성합니다. 또한 암호화 키 자료는 안전하게 래핑되고 비FIPS 환경에서 래핑되지 않는 한 FIPS 환경을 남겨 두지 않아야 합니다.

fips-mode-setup 툴을 사용하여 시스템을 FIPS 모드로 전환해도 FIPS 140 표준을 준수하지 않습니다. 시스템을 FIPS 모드로 설정한 후 모든 암호화 키를 다시 생성할 수 없을 수 있습니다. 예를 들어 사용자의 암호화 키가 있는 기존 IdM 영역의 경우 모든 키를 다시 생성할 수 없습니다. FIPS 모드에서 설치를 시작할 수 없는 경우 설치 후 구성 단계를 수행하거나 워크로드를 설치하기 전에 설치 후 첫 번째 단계로 항상 FIPS 모드를 활성화합니다.

fips-mode-setup 툴에서는 내부적으로 FIPS 시스템 전체 암호화 정책도 사용합니다. 그러나 update-crypto-policies --set FIPS 명령이 수행하는 작업 위에 도구를 사용하여 FIPS dracut 모듈을 설치할 수 있습니다. fips- finish-installfips=1 부팅 옵션도 커널 명령줄에 추가하고 초기 RAM 디스크를 다시 생성합니다.

또한 FIPS 모드에서 필요한 제한 적용은 /proc/sys/crypto/fips_enabled 파일의 콘텐츠에 따라 다릅니다. 파일에 1 개의 암호화 구성 요소가 포함된 경우 RHEL 코어 암호화 구성 요소는 FIPS 승인 암호화 알고리즘 구현만 사용하는 모드로 전환됩니다. /proc/sys/crypto/fips_enabled 에 0 이 포함된 경우 암호화 구성 요소에서 FIPS 모드를 활성화하지 않습니다.

FIPS 시스템 전체 암호화 정책은 높은 수준의 제한을 구성하는 데 도움이 됩니다. 따라서 암호화 민첩성을 지원하는 통신 프로토콜은 선택한 경우 시스템이 거부하는 암호를 알리지 않습니다. 예를 들어,keCha20 알고리즘은 FIPS 승인되지 않으며 FIPS 암호화 정책은 TLS 서버 및 클라이언트가 TLS_ECDHE_ECDSA_WITH_CHACHA20_POLY1305_SHA256 TLS 암호화 제품군을 발표하지 않도록 합니다.

FIPS 모드에서 RHEL을 작동하고 자체 FIPS 모드 관련 구성 옵션을 제공하는 애플리케이션을 사용하는 경우 이러한 옵션과 해당 애플리케이션 지침을 무시합니다. FIPS 모드에서 실행되는 시스템 및 시스템 전체 암호화 정책은 FIPS 호환 암호화만 적용합니다. 예를 들어, 시스템이 FIPS 모드에서 실행되는 경우 Node.js 구성 옵션 --enable-fips 는 무시됩니다. FIPS 모드에서 실행되지 않는 시스템에서 --enable-fips 옵션을 사용하는 경우 FIPS-140 규정 준수 요구 사항을 충족하지 않습니다.

RHEL 9의 암호화 모듈은 NIST(National Institute of Standards and Technology) 암호화 모듈 검증 프로그램(CMVP)에서 FIPS 140-3 요구 사항에 대해 아직 인증되지 않았습니다. 규정 준수 활동 및 정부 표준 지식 베이스 문서에서 암호화 모듈 FIPS 140-2 및 FIPS 140-3 섹션의 검증 상태를 확인할 수 있습니다.

FIPS 모드에서 실행되는 RHEL 9.2 이상 시스템은 모든 TLS 1.2 연결이 FIPS 140-3 표준의 필요에 따라 확장 마스터 보안(ECDSA) 확장(RFC 7627)을 사용해야 함을 강제합니다. 따라서 ECDSA 또는 TLS 1.3을 지원하지 않는 레거시 클라이언트는 FIPS 모드에서 실행되는 RHEL 9 서버에 연결할 수 없으며 FIPS 모드의 RHEL 9 클라이언트는 ECDSA 없이 TLS 1.2만 지원하는 서버에 연결할 수 없습니다. Red Hat Enterprise Linux 9.2에서 적용된 TLS 확장 "확장 마스터 시크릿"을 참조하십시오.

2.2. FIPS 모드가 활성화된 시스템 설치

FIPS(Federal Information Processing Standard) 140에서 요구하는 암호화 모듈 자체 점검을 활성화하려면 시스템 설치 중에 FIPS 모드를 활성화합니다.

RHEL 설치 중에 FIPS 모드를 활성화하면 시스템이 FIPS 승인 알고리즘 및 지속적인 모니터링 테스트를 사용하여 모든 키를 생성합니다.

절차

-

시스템 설치 중에 커널 명령줄에

fips=1옵션을 추가합니다. - 소프트웨어 선택 단계에서는 타사 소프트웨어를 설치하지 마십시오.

- 설치 후 FIPS 모드에서 시스템이 자동으로 시작됩니다.

검증

시스템이 시작된 후 FIPS 모드가 활성화되었는지 확인합니다.

$ fips-mode-setup --check FIPS mode is enabled.

추가 리소스

- RHEL Installer용 부팅 옵션 문서의 부팅 옵션 편집 섹션

2.3. 추가 리소스

3장. 시스템 전체 암호화 정책 사용

시스템 전체의 암호화 정책은 TLS, IPsec, SSH, DNSSec 및 Kerberos 프로토콜을 다루는 코어 암호화 하위 시스템을 구성하는 시스템 구성 요소입니다. 관리자가 선택할 수 있는 몇 가지 정책 세트를 제공합니다.

3.1. 시스템 전체 암호화 정책

시스템 전체 정책이 설정되면 RHEL의 애플리케이션은 이를 따르며 애플리케이션을 명시적으로 요청하지 않는 한, 정책을 준수하지 않는 알고리즘과 프로토콜을 사용하지 않습니다. 즉, 이 정책은 시스템 제공 구성으로 실행할 때 애플리케이션의 기본 동작에 적용되지만 필요한 경우 이를 재정의할 수 있습니다.

RHEL 9에는 다음과 같은 사전 정의된 정책이 포함되어 있습니다.

DEFAULT- 기본 시스템 전체 암호화 정책 수준은 현재 위협 모델에 대한 보안 설정을 제공합니다. 이 보안 설정은 TLS 1.2 및 1.3 프로토콜과 IKEv2 및 SSH2 프로토콜을 허용합니다. RSA 키와 Diffie-Hellman 매개변수는 2048비트 이상인 경우 허용됩니다.

LEGACY- Red Hat Enterprise Linux 6 및 이전 버전과의 호환성을 극대화하며 공격 면적이 증가하여 보안이 떨어집니다. SHA-1은 TLS 해시, 서명 및 알고리즘으로 사용할 수 있습니다. CBC-mode 암호는 SSH와 함께 사용할 수 있습니다. GnuTLS를 사용하는 애플리케이션에서는 SHA-1로 서명된 인증서를 허용합니다. 이 보안 설정은 TLS 1.2 및 1.3 프로토콜과 IKEv2 및 SSH2 프로토콜을 허용합니다. RSA 키와 Diffie-Hellman 매개변수는 2048비트 이상인 경우 허용됩니다.

FUTURE- 가능한 향후 정책을 테스트하기 위한 보다 엄격한 미래 지향 보안 수준입니다. 이 정책은 DNSSec에서 SHA-1을 사용하거나 HMAC로 사용할 수 없습니다. SHA2-224 및 SHA3-224 해시는 거부됩니다. 128비트 암호가 비활성화되어 있습니다. Kerberos를 제외한 CBC 모드 암호는 비활성화되어 있습니다. 이 보안 설정은 TLS 1.2 및 1.3 프로토콜과 IKEv2 및 SSH2 프로토콜을 허용합니다. RSA 키와 Diffie-Hellman 매개변수는 최소 3072비트인 경우 허용됩니다. 시스템이 공용 인터넷에서 통신할 경우 상호 운용성 문제에 직면할 수 있습니다.

FIPS-

FIPS 140 요구 사항을 준수합니다. RHEL 시스템을 FIPS 모드로 전환하는

fips-mode-setup툴은 내부적으로 이 정책을 사용합니다.FIPS정책으로 전환해도 FIPS 140 표준을 준수하지 않습니다. 또한 시스템을 FIPS 모드로 설정한 후 모든 암호화 키를 다시 생성해야 합니다. 많은 경우에서는 이 작업을 수행할 수 없습니다.

Red Hat은 LEGACY 정책을 사용하는 경우를 제외하고 모든 라이브러리가 보안 기본값을 제공하도록 모든 정책 수준을 지속적으로 조정합니다. LEGACY 프로필은 보안 기본값을 제공하지 않지만 쉽게 사용할 수 있는 알고리즘은 포함되지 않습니다. 따라서 Red Hat Enterprise Linux의 라이프 사이클 기간 동안 제공되는 정책에서 활성화된 알고리즘이나 사용 가능한 주요 크기 세트가 변경될 수 있습니다.

이러한 변경 사항은 새로운 보안 표준과 새로운 보안 연구를 반영합니다. Red Hat Enterprise Linux의 전체 수명 동안 특정 시스템과의 상호 운용성을 보장해야 하는 경우 시스템과 상호 작용하는 구성 요소에 대한 시스템 전체 암호화 정책을 비활성화하거나 사용자 지정 암호화 정책을 사용하여 특정 알고리즘을 다시 활성화해야 합니다.

고객 포털 API의 인증서에서 사용하는 암호화 키가 FUTURE 시스템 전체 암호화 정책의 요구 사항을 충족하지 않으므로 redhat-support-tool 유틸리티는 현재 이 정책 수준에서 작동하지 않습니다.

이 문제를 해결하려면 고객 포털 API에 연결하는 동안 DEFAULT 암호화 정책을 사용합니다.

정책 수준에서 허용되는 대로 설명된 특정 알고리즘 및 암호는 애플리케이션에서 지원하는 경우에만 사용할 수 있습니다.

암호화 정책을 관리하는 툴

현재 시스템 전체 암호화 정책을 보거나 변경하려면 update-crypto-policies 도구를 사용합니다. 예를 들면 다음과 같습니다.

$ update-crypto-policies --show DEFAULT # update-crypto-policies --set FUTURE Setting system policy to FUTURE

암호화 정책 변경이 적용되었는지 확인하려면 시스템을 다시 시작합니다.

안전하지 않은 암호화 제품군 및 프로토콜을 제거하여 강력한 암호화 기본값

다음 목록에는 RHEL의 코어 암호화 라이브러리에서 제거된 암호화 제품군 및 프로토콜이 포함되어 있습니다. 소스에는 존재하지 않거나 빌드 중에 지원이 비활성화되므로 애플리케이션에서 사용할 수 없습니다.

- DES (RHEL 7 이후)

- 모든 내보내기 등급 암호화 제품군 (RHEL 7 이후)

- 서명된 MD5 (RHEL 7 이후)

- SSLv2 (RHEL 7 이후)

- SSLv3 (RHEL 8 이후)

- 모든 ECC 곡선 < 224bit (RHEL 6 이후)

- 모든 바이너리 필드 ECC 곡선 (RHEL 6 이후)

모든 정책 수준에서 사용되지 않는 알고리즘

다음 알고리즘은 RHEL 9에 포함된 LEGACY,DEFAULT,FUTURE 및 FIPS 암호화 정책에서 비활성화되어 있습니다. 사용자 지정 암호화 정책을 적용하거나 개별 애플리케이션의 명시적 구성을 통해서만 활성화할 수 있지만 결과 구성은 제품 지원 범위를 벗어납니다.

- 버전 1.2 이전 TLS(RHEL 9 이후)는 <RHEL 8에서 1.0임)

- 버전 1.2 이전의 DTLS (RHEL 9 이후)는 <RHEL 8에서 1.0임)

- 매개변수가 있는 DH < 2048비트(RHEL 9 이후)는 <RHEL 8에서 1024비트)

- 키 크기가 있는 RSA < 2048비트(RHEL 9 이후)는 <RHEL 8에서 1024비트)

- DSA (RHEL 9 이후)는 <RHEL 8에서 1024 비트)

- 3DES (RHEL 9 이후)

- RC4 (RHEL 9 이후)

- FFDHE-1024 (RHEL 9 이후)

- DHE-DSS (RHEL 9 이후)

- Camellia(RHEL 9 이후)

- ARIA

- IKEv1 (RHEL 8 이후)

암호화 정책에서 활성화된 알고리즘

각 암호화 정책은 특정 암호화 제품군 및 프로토콜을 활성화합니다.

LEGACY | DEFAULT | FIPS | FUTURE | |

|---|---|---|---|---|

| IKEv1 | 제공되지 않음 | 제공되지 않음 | 제공되지 않음 | 제공되지 않음 |

| 3DES | 제공되지 않음 | 제공되지 않음 | 제공되지 않음 | 제공되지 않음 |

| RC4 | 제공되지 않음 | 제공되지 않음 | 제공되지 않음 | 제공되지 않음 |

| DH | 최소 2048비트 | 최소 2048비트 | 최소 2048비트 | 최소 3072비트 |

| RSA | 최소 2048비트 | 최소 2048비트 | 최소 2048비트 | 최소 3072비트 |

| DSA | 제공되지 않음 | 제공되지 않음 | 제공되지 않음 | 제공되지 않음 |

| TLS v1.1 이상 | 제공되지 않음 | 제공되지 않음 | 제공되지 않음 | 제공되지 않음 |

| TLS v1.2 이상 | 제공됨 | 제공됨 | 제공됨 | 제공됨 |

| 디지털 서명 및 인증서의 SHA-1 | 제공됨 | 제공되지 않음 | 제공되지 않음 | 제공되지 않음 |

| CBC 모드 암호 | 제공됨 | 제공되지 않음[a] | 제공되지 않음[b] | 제공되지 않음[c] |

| 키 < 256비트인 대칭 암호 | 제공됨 | 제공됨 | 제공됨 | 제공되지 않음 |

[a]

SSH에 대해 CBC 암호가 비활성화되어 있습니다

[b]

Kerberos를 제외한 모든 프로토콜에 대해 CBC 암호가 비활성화되어 있습니다.

[c]

Kerberos를 제외한 모든 프로토콜에 대해 CBC 암호가 비활성화되어 있습니다.

| ||||

추가 리소스

-

update-crypto-policies(8)도움말 페이지

3.2. 시스템 전체 암호화 정책을 이전 릴리스와 호환되는 모드로 전환

Red Hat Enterprise Linux 9의 기본 시스템 전체 암호화 정책은 이전의 안전하지 않은 프로토콜을 사용한 통신을 허용하지 않습니다. Red Hat Enterprise Linux 6 및 이전 릴리스와 호환되어야 하는 환경의 경우 LEGACY 정책 수준을 사용할 수 있습니다.

LEGACY 정책 수준으로 전환하면 덜 안전한 시스템 및 애플리케이션이 됩니다.

절차

시스템 전체 암호화 정책을

LEGACY수준으로 전환하려면root로 다음 명령을 입력합니다.# update-crypto-policies --set LEGACY Setting system policy to LEGACY

추가 리소스

-

사용 가능한 암호화 정책 수준 목록은

update-crypto-policies(8)도움말 페이지를 참조하십시오. -

사용자 지정 암호화 정책을 정의하려면

update-crypto-policies(8)도움말 페이지의Custom Policies섹션 및crypto-policies(7)도움말 페이지의Crypto Policy Definition Format섹션을 참조하십시오.

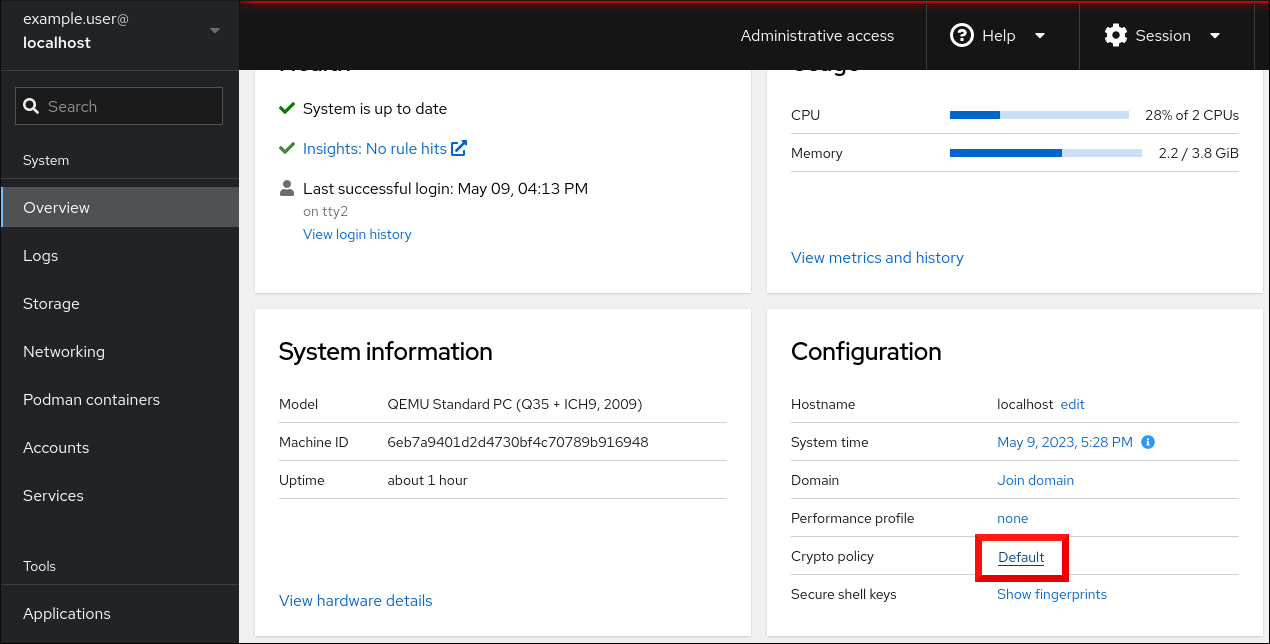

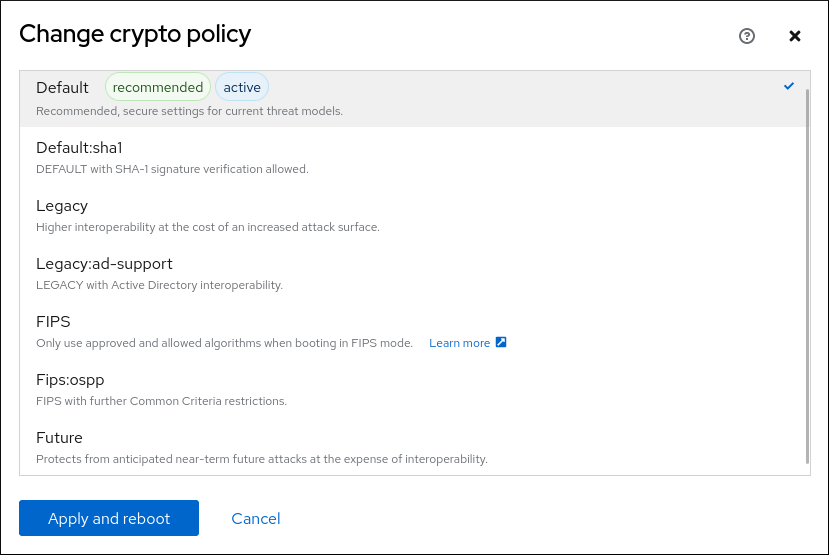

3.3. 웹 콘솔에서 시스템 전체 암호화 정책 설정

RHEL 웹 콘솔 인터페이스에서 직접 시스템 전체 암호화 정책 및 하위 정책 중 하나를 설정할 수 있습니다. 사전 정의된 시스템 전체 암호화 정책 외에도 그래픽 인터페이스를 통해 다음과 같은 정책 및 하위 정책 조합을 적용할 수도 있습니다.

DEFAULT:SHA1-

SHA-1알고리즘이 활성화된DEFAULT정책입니다. LEGACY:AD-SUPPORT-

Active Directory 서비스의 상호 운용성을 개선하는 보안 설정이 적은

LEGACY정책입니다. FIPS:OSPP-

정보 기술 보안 평가 표준에 대한 Common Criteria에서 영향을 받는 추가 제한이 있는

FIPS정책입니다.

사전 요구 사항

- RHEL 9 웹 콘솔이 설치되어 있습니다. 자세한 내용은 웹 콘솔 설치 및 활성화를 참조하십시오.

-

sudo를 사용하여 관리 명령을 입력할 수 있는루트권한 또는 권한이 있습니다.

절차

- 웹 콘솔에 로그인합니다. 자세한 내용은 웹 콘솔에 로그인을 참조하십시오.

개요 페이지의 구성 카드에서 policy 옆에 있는 현재 정책 값을 클릭합니다.

암호화 정책 변경 대화 상자에서 시스템에서 사용을 시작할 정책을 클릭합니다.

- 적용 및 재부팅 버튼을 클릭합니다.

검증

-

다시 시작한 후 웹 콘솔에 다시 로그인하고 Crypto 정책 값이 선택한 값에 해당하는지 확인합니다. 또는

update-crypto-policies --show명령을 입력하여 현재 시스템 전체 암호화 정책을 터미널에 표시할 수 있습니다.

3.4. 시스템을 FIPS 모드로 전환

시스템 전체 암호화 정책에는 FIPS(Federal Information Processing Standard) 발행 140의 요구 사항에 따라 암호화 알고리즘을 활성화하는 정책 수준이 포함되어 있습니다. FIPS 모드를 활성화하거나 비활성화하는 fips-mode-setup 툴은 FIPS 시스템 전체 암호화 정책을 내부적으로 사용합니다.

FIPS 시스템 전체 암호화 정책을 사용하여 시스템을 FIPS 모드로 전환해도 FIPS 140 표준을 준수하는 것은 아닙니다. 시스템을 FIPS 모드로 설정한 후 모든 암호화 키를 다시 생성할 수 없을 수 있습니다. 예를 들어 사용자의 암호화 키가 있는 기존 IdM 영역의 경우 모든 키를 다시 생성할 수 없습니다.

fips-mode-setup 툴은 내부적으로 FIPS 정책을 사용합니다. 그러나 --set FIPS 옵션을 사용하는 update-crypto-policies 명령에서 fips-mode-setup 을 사용하면 fips-finish-install 도구를 사용하여 FIPS dracut 모듈을 설치할 수 있습니다. 또한 fips=1 부팅 옵션도 커널 명령줄에 다시 생성되고 초기 RAM 디스크를 다시 생성합니다.

RHEL 설치 중에 FIPS 모드를 활성화하면 시스템이 FIPS 승인 알고리즘 및 지속적인 모니터링 테스트를 사용하여 모든 키를 생성합니다.

RHEL 9의 암호화 모듈은 FIPS 140-3 요구 사항에 대해 아직 인증되지 않았습니다.

절차

시스템을 FIPS 모드로 전환하려면 다음을 수행합니다.

# fips-mode-setup --enable Kernel initramdisks are being regenerated. This might take some time. Setting system policy to FIPS Note: System-wide crypto policies are applied on application start-up. It is recommended to restart the system for the change of policies to fully take place. FIPS mode will be enabled. Please reboot the system for the setting to take effect.커널이 FIPS 모드로 전환되도록 시스템을 다시 시작하십시오.

# reboot

검증

재시작 후 FIPS 모드의 현재 상태를 확인할 수 있습니다.

# fips-mode-setup --check FIPS mode is enabled.

추가 리소스

-

fips-mode-setup(8)도움말 페이지 - FIPS 모드에서 시스템 설치

- NIST(National Institute of Standards and Technology) 웹 사이트의 암호화 모듈에 대한 보안 요구 사항.

3.5. 컨테이너에서 FIPS 모드 활성화

FIPS 모드(Federal Information Processing Standard)에서 요구하는 전체 암호화 모듈 자체 점검을 활성화하려면 호스트 시스템 커널이 FIPS 모드에서 실행되어야 합니다. podman 유틸리티는 지원되는 컨테이너에서 FIPS 모드를 자동으로 활성화합니다.

fips-mode-setup 명령은 컨테이너에서 제대로 작동하지 않으며 이 시나리오에서는 FIPS 모드를 활성화하거나 확인하는 데 사용할 수 없습니다.

RHEL 9의 암호화 모듈은 FIPS 140-3 요구 사항에 대해 아직 인증되지 않았습니다.

사전 요구 사항

- 호스트 시스템은 FIPS 모드여야 합니다.

절차

-

FIPS 모드가 활성화된 시스템에서

podman유틸리티는 지원되는 컨테이너에서 FIPS 모드를 자동으로 활성화합니다.

추가 리소스

3.6. FIPS 140-3와 호환되지 않는 암호화를 사용하는 RHEL 애플리케이션 목록

FIPS 140-3과 같은 모든 관련 암호화 인증을 전달하려면 코어 암호화 구성 요소 집합의 라이브러리를 사용합니다. libgcrypt 를 제외한 이러한 라이브러리는 RHEL 시스템 전체 암호화 정책도 따릅니다.

핵심 암호화 구성 요소에 대한 개요, 선택한 방법, 운영 체제에 어떻게 통합되는지, 하드웨어 보안 모듈 및 스마트 카드를 지원하는 방법, 암호화 인증이 적용되는 방법에 대한 정보는 RHEL 핵심 암호화 구성 요소 문서를 참조하십시오.

FIPS 140-3와 호환되지 않는 암호화를 사용하는 RHEL 9 애플리케이션 목록

- Bacula

- CRAM-MD5 인증 프로토콜을 구현합니다.

- Cyrus SASL

- SCRAM-SHA-1 인증 방법을 사용합니다.

- Dovecot

- SCRAM-SHA-1을 사용합니다.

- Emacs

- SCRAM-SHA-1을 사용합니다.

- FreeRADIUS

- 인증 프로토콜을 위해 MD5 및 SHA-1을 사용합니다.

- Ghostscript

- 사용자 정의 암호화 구현(MD5, RC4, SHA-2, AES)은 문서를 암호화하고 해독합니다.

- GRUB2

-

SHA-1이 필요한 레거시 펌웨어 프로토콜을 지원하며

libgcrypt라이브러리를 포함합니다. - iPXE

- TLS 스택을 구현합니다.

- Kerberos

- SHA-1(Windows와의 상호 운용성)에 대한 지원을 유지합니다.

- lasso

-

lasso_wsse_username_token_derive_key()키 파생 기능(KDF)은 SHA-1을 사용합니다. - MariaDB, MariaDB 커넥터

-

mysql_native_password인증 플러그인은 SHA-1을 사용합니다. - MySQL

-

mysql_native_password는 SHA-1을 사용합니다. - OpenIPMI

- RAKP-HMAC-MD5 인증 방법은 FIPS 사용에 대해 승인되지 않으며 FIPS 모드에서 작동하지 않습니다.

- OVMF (UEFI 펌웨어), Edk2, shim

- 전체 암호화 스택( OpenSSL 라이브러리의 임베디드 사본).

- Perl

- HMAC, HMAC-SHA1, SHA-1, SHA-224,…을 사용합니다.

- Pidgin

- DES 및 RC4 암호를 구현합니다.

- PKCS #12 파일 처리 (OpenSSL, GnuTLS, NSS, Firefox, Java)

- 전체 파일 HMAC를 계산하는 데 사용되는 KDF(Key Derivation Function)는 FIPS를 승인하지 않기 때문에 PKCS #12의 모든 사용은 FIPS와 호환되지 않습니다. 따라서 PKCS #12 파일은 FIPS 컴플라이언스를 위해 일반 텍스트로 간주됩니다. 키 전송 용도의 경우 FIPS 승인 암호화 스키마를 사용하여 PKCS #12 (.p12) 파일을 래핑합니다.

- poppler

- 서명, 암호 및 암호화가 원본 website (예: MD5, RC4, 및 SHA-1)에 있는 경우 허용되지 않은 알고리즘을 기반으로 CoreDNS를 저장할 수 있습니다.

- PostgreSQL

- Blowfish, DES 및 MD5를 구현합니다. KDF는 SHA-1을 사용합니다.

- QAT Engine

- 암호화 프리미티브의 혼합 하드웨어 및 소프트웨어 구현(RSA, EC, DH, AES,…)

- Ruby

- 비보안 MD5 및 SHA-1 라이브러리 기능을 제공합니다.

- Samba

- RC4 및 DES (Windows와의 상호 운용성)에 대한 지원 유지

- Syslinux

- BIOS 암호는 SHA-1을 사용합니다.

- 바인딩되지 않음

- DNS 사양을 사용하려면 DNSSEC 확인자가 DNSKEY 레코드에서 SHA-1 기반 알고리즘을 사용하여 유효성을 검사해야 합니다.

- valgrind

- AES, SHA 해시.[2]

추가 리소스

3.7. 다음 시스템 전체 암호화 정책에서 애플리케이션 제외

애플리케이션에서 직접 지원되는 암호화 제품군 및 프로토콜을 구성하여 애플리케이션에서 사용하는 암호화 설정을 사용자 지정할 수 있습니다.

애플리케이션과 관련된 심볼릭 링크를 /etc/crypto-policies/back-ends 디렉터리에서 제거하고 사용자 지정 암호화 설정으로 바꿀 수도 있습니다. 이 구성을 사용하면 제외된 백엔드를 사용하는 애플리케이션의 시스템 전체 암호화 정책을 사용할 수 없습니다. 또한 이러한 수정은 Red Hat에서 지원하지 않습니다.

3.7.1. 시스템 차원의 암호화 정책 옵트아웃의 예

wget

wget 네트워크 다운로드자가 사용하는 암호화 설정을 사용자 지정하려면 --secure-protocol 및 --ciphers 옵션을 사용합니다. 예를 들어 다음과 같습니다.

$ wget --secure-protocol=TLSv1_1 --ciphers="SECURE128" https://example.com

자세한 내용은 wget(1) 도움말 페이지의 HTTPS(SSL/TLS) 옵션 섹션을 참조하십시오.

curl

curl 툴에서 사용하는 암호를 지정하려면 --ciphers 옵션을 사용하고 콜론으로 구분된 암호 목록을 값으로 제공합니다. 예를 들어 다음과 같습니다.

$ curl https://example.com --ciphers '@SECLEVEL=0:DES-CBC3-SHA:RSA-DES-CBC3-SHA'

자세한 내용은 curl(1) 도움말 페이지를 참조하십시오.

Firefox

Firefox 웹 브라우저에서 시스템 전체 암호화 정책을 비활성화할 수는 없지만 Firefox 의 구성 편집기에서 지원되는 암호 및 TLS 버전을 추가로 제한할 수 있습니다. 주소 표시줄에 about:config를 입력하고 필요에 따라 security.tls.version.min 옵션의 값을 변경합니다. security.tls.version.min 을 1 로 설정하면 필요한 최소 TLS 1.0이 허용되며, security.tls.version.min 2 는 TLS 1.1을 활성화합니다.

OpenSSH

OpenSSH 서버에 대한 시스템 전체 암호화 정책을 비활성화하려면 /etc/ssh/sshd_config.d/ 디렉터리에 있는 드롭인 구성 파일에 암호화 정책을 지정하려면 /etc/ssh/sshd_config.d/ 디렉터리에 있는 암호화 정책을 지정하여 두 자리 숫자 접두사가 접미사로 지정합니다.

50-redhat.conf 파일 앞에 있고 .conf 접미사를 .conf

자세한 내용은 sshd_config(5) 도움말 페이지를 참조하십시오.

OpenSSH 클라이언트에 대한 시스템 전체 암호화 정책을 비활성화하려면 다음 작업 중 하나를 수행합니다.

-

지정된 사용자의 경우

~/.ssh/를 재정의합니다.config 파일의 사용자별 구성으로 글로벌 ssh_config -

전체 시스템의 경우

/etc/ssh/ssh_config.d/디렉터리에 있는 드롭인 구성 파일에 암호화 정책을 지정하고 두 자리 숫자 접두사가50-redhat.conf파일 앞에 있고.conf접미사(예:49-crypto-policy-override.conf)를 사용합니다.

자세한 내용은 ssh_config(5) 도움말 페이지를 참조하십시오.

Libreswan

자세한 내용은 보안 네트워크 문서에서 시스템 전체 암호화 정책을 거부하는 IPsec 연결 구성을 참조하십시오.

추가 리소스

-

update-crypto-policies(8)도움말 페이지

3.8. 하위 정책을 사용하여 시스템 전체 암호화 정책 사용자 정의

활성화된 암호화 알고리즘 또는 프로토콜 집합을 조정하려면 다음 절차를 사용하십시오.

기존 시스템 전체 암호화 정책에 사용자 지정 하위 정책을 적용하거나 이러한 정책을 처음부터 정의할 수 있습니다.

범위가 지정된 정책의 개념은 다양한 백엔드에 대해 다양한 알고리즘 세트를 활성화할 수 있습니다. 각 구성 지시문을 특정 프로토콜, 라이브러리 또는 서비스로 제한할 수 있습니다.

또한 지시문은 와일드카드를 사용하여 여러 값을 지정하는 데 별표를 사용할 수 있습니다.

/etc/crypto-policies/state/CURRENT.pol 파일에는 와일드카드 확장 후 현재 적용되는 시스템 전체 암호화 정책의 모든 설정이 나열됩니다. 암호화 정책을 보다 엄격하게 설정하려면 /usr/share/crypto-policies/policies/FUTURE.pol 파일에 나열된 값을 사용하는 것이 좋습니다.

/usr/share/crypto-policies/policies/modules/ 디렉토리에서 예제 하위 정책을 찾을 수 있습니다. 이 디렉터리의 하위 정책 파일에는 주석 처리된 줄에 대한 설명도 포함되어 있습니다.

절차

/etc/crypto-policies/policies/modules/디렉토리로 체크아웃합니다.# cd /etc/crypto-policies/policies/modules/조정을 위한 하위 정책을 생성합니다. 예를 들면 다음과 같습니다.

# touch MYCRYPTO-1.pmod # touch SCOPES-AND-WILDCARDS.pmod

중요정책 모듈의 파일 이름에 대문자를 사용합니다.

선택한 텍스트 편집기에서 정책 모듈을 열고 시스템 전체 암호화 정책을 수정하는 옵션을 삽입합니다. 예를 들면 다음과 같습니다.

# vi MYCRYPTO-1.pmodmin_rsa_size = 3072 hash = SHA2-384 SHA2-512 SHA3-384 SHA3-512

# vi SCOPES-AND-WILDCARDS.pmod# Disable the AES-128 cipher, all modes cipher = -AES-128-* # Disable CHACHA20-POLY1305 for the TLS protocol (OpenSSL, GnuTLS, NSS, and OpenJDK) cipher@TLS = -CHACHA20-POLY1305 # Allow using the FFDHE-1024 group with the SSH protocol (libssh and OpenSSH) group@SSH = FFDHE-1024+ # Disable all CBC mode ciphers for the SSH protocol (libssh and OpenSSH) cipher@SSH = -*-CBC # Allow the AES-256-CBC cipher in applications using libssh cipher@libssh = AES-256-CBC+

- 모듈 파일의 변경 사항을 저장합니다.

DEFAULT시스템 전체 암호화 정책 수준에 정책 조정을 적용합니다.# update-crypto-policies --set DEFAULT:MYCRYPTO-1:SCOPES-AND-WILDCARDS이미 실행 중인 서비스 및 애플리케이션에 암호화 설정을 적용하려면 시스템을 다시 시작하십시오.

# reboot

검증

/etc/crypto-policies/state/CURRENT.pol파일에 변경 사항이 포함되어 있는지 확인합니다. 예를 들면 다음과 같습니다.$ cat /etc/crypto-policies/state/CURRENT.pol | grep rsa_size min_rsa_size = 3072

추가 리소스

-

update-crypto-policies(8)도움말 페이지의Custom Policies섹션 -

crypto-policies(7)도움말 페이지의Crypto Policy Definition Format섹션 - RHEL 8.2에서 암호화 정책을 사용자 지정하는 방법에 대한 Red Hat 블로그 기사

3.9. SHA-1 재활성화

서명 생성 및 확인에 SHA-1 알고리즘을 사용하는 것은 DEFAULT 암호화 정책에서 제한됩니다. 시나리오에 기존 또는 타사 암호화 서명을 확인하는 데 SHA-1을 사용해야 하는 경우 RHEL 9에서 기본적으로 제공하는 SHA1 하위 정책을 적용하여 활성화할 수 있습니다. 이는 시스템의 보안을 저하시킵니다.

사전 요구 사항

-

시스템은

DEFAULT시스템 전체 암호화 정책을 사용합니다.

절차

SHA1하위 정책을DEFAULT암호화 정책에 적용합니다.# update-crypto-policies --set DEFAULT:SHA1 Setting system policy to DEFAULT:SHA1 Note: System-wide crypto policies are applied on application start-up. It is recommended to restart the system for the change of policies to fully take place.시스템을 다시 시작하십시오.

# reboot

검증

현재 암호화 정책을 표시합니다.

# update-crypto-policies --show DEFAULT:SHA1

update-crypto-policies --set 명령을 사용하여 LEGACY 암호화 정책으로 전환하면 서명에 SHA-1이 활성화됩니다. 그러나 LEGACY LEGACY 암호화 정책은 다른 약한 암호화 알고리즘을 활성화하여 시스템을 훨씬 더 취약하게 만듭니다. SHA-1 서명 이외의 다른 레거시 암호화 알고리즘을 사용해야 하는 시나리오에만 이 해결 방법을 사용하십시오.

3.10. 사용자 정의 시스템 전체 암호화 정책 생성 및 설정

다음 단계에서는 전체 정책 파일로 시스템 전체 암호화 정책 사용자 지정을 보여줍니다.

절차

사용자 지정 정책 파일을 생성합니다.

# cd /etc/crypto-policies/policies/ # touch MYPOLICY.pol

또는 사전 정의된 4가지 정책 수준 중 하나를 복사하여 시작합니다.

# cp /usr/share/crypto-policies/policies/DEFAULT.pol /etc/crypto-policies/policies/MYPOLICY.pol다음과 같은 요구 사항에 맞게 선택한 텍스트 편집기에서 사용자 지정 암호화 정책으로 파일을 편집합니다.

# vi /etc/crypto-policies/policies/MYPOLICY.pol시스템 전체 암호화 정책을 사용자 지정 수준으로 전환합니다.

# update-crypto-policies --set MYPOLICY이미 실행 중인 서비스 및 애플리케이션에 암호화 설정을 적용하려면 시스템을 다시 시작하십시오.

# reboot

추가 리소스

-

update-crypto-policies(8)도움말 페이지의Custom Policies섹션 및crypto-policies(7)도움말 페이지의Crypto Policy Definition Format섹션 - RHEL에서 암호화 정책을 사용자 지정하는 방법에 대한 Red Hat 블로그 기사

4장. crypto-policies RHEL 시스템 역할을 사용하여 사용자 정의 암호화 정책 설정

관리자는 crypto_policies RHEL 시스템 역할을 사용하여 Ansible Core 패키지를 사용하여 다양한 시스템에서 사용자 정의 암호화 정책을 신속하고 일관되게 구성할 수 있습니다.

4.1. crypto_policies 시스템 역할 변수 및 사실

crypto_policies System Role Playbook에서는 사용자의 기본 설정 및 제한 사항에 따라 crypto_policies 구성 파일에 대한 매개변수를 정의할 수 있습니다.

변수를 구성하지 않으면 시스템 역할은 시스템을 구성하지 않고 팩트만 보고합니다.

crypto_policies 시스템 역할에 대해 선택된 변수

crypto_policies_policy- 시스템 역할이 관리형 노드에 적용되는 암호화 정책을 결정합니다. 다양한 암호화 정책에 대한 자세한 내용은 시스템 전체 암호화 정책을 참조하십시오.

crypto_policies_reload-

yes로 설정되면 영향을 받는 서비스 (현재ipsec,bind,sshd서비스)로 설정된 경우 암호화 정책을 적용한 후 다시 로드합니다. 기본값은yes입니다. crypto_policies_reboot_ok-

yes로 설정하고 시스템 역할이 암호화 정책을 변경한 후 재부팅이 필요한 경우crypto_policies_reboot_required를yes로 설정합니다. 기본값은no입니다.

crypto_policies 시스템 역할에 의해 설정된 사실

crypto_policies_active- 현재 선택한 정책을 나열합니다.

crypto_policies_available_policies- 시스템에서 사용 가능한 모든 정책을 나열합니다.

crypto_policies_available_subpolicies- 시스템에서 사용 가능한 모든 하위 정책을 나열합니다.

추가 리소스

4.2. crypto_policies 시스템 역할을 사용하여 사용자 정의 암호화 정책 설정

crypto_policies 시스템 역할을 사용하여 단일 제어 노드에서 다수의 관리형 노드를 일관되게 구성할 수 있습니다.

사전 요구 사항

-

crypto_policies시스템 역할로 설정하려는 하나 이상의 관리형 노드에 대한 액세스 및 권한. Red Hat Ansible Core가 기타 시스템을 구성하는 시스템인 제어 노드에 대한 액세스 및 권한.

제어 노드에서 다음을 수행합니다.

-

ansible-core및rhel-system-roles패키지가 설치됩니다.

-

RHEL 8.0-8.5는 Ansible 기반 자동화를 위해 Ansible Engine 2.9가 포함된 별도의 Ansible 리포지토리에 대한 액세스를 제공했습니다. Ansible Engine에는 ansible, ansible-playbook, docker 및 podman과 같은 커넥터, 여러 플러그인 및 모듈과 같은 명령줄 유틸리티가 포함되어 있습니다. Ansible Engine을 확보하고 설치하는 방법에 대한 자세한 내용은 Red Hat Ansible Engine 지식베이스 문서를 다운로드하고 설치하는 방법을 참조하십시오.

RHEL 8.6 및 9.0에서는 Ansible 명령줄 유틸리티, 명령 및 소규모의 기본 제공 Ansible 플러그인 세트가 포함된 Ansible Core( ansible-core 패키지로 제공)를 도입했습니다. RHEL은 AppStream 리포지토리를 통해 이 패키지를 제공하며 제한된 지원 범위를 제공합니다. 자세한 내용은 RHEL 9 및 RHEL 8.6 이상 AppStream 리포지토리 지식 베이스에 포함된 Ansible Core 패키지에 대한 지원 범위에 대한 지식베이스 문서를 참조하십시오.

- 관리 노드를 나열하는 인벤토리 파일.

절차

다음 내용으로 새

playbook.yml파일을 생성합니다.--- - hosts: all tasks: - name: Configure crypto policies include_role: name: rhel-system-roles.crypto_policies vars: - crypto_policies_policy: FUTURE - crypto_policies_reboot_ok: true예를 들어 FUTURE 값을 선호하는 암호화 정책으로 교체할 수 있습니다.

DEFAULT,LEGACY및FIPS:OSPP.crypto_policies_reboot_ok: true변수를 사용하면 시스템 역할에서 암호화 정책을 변경한 후 시스템이 재부팅됩니다.자세한 내용은 crypto_policies 시스템 역할 변수 및 팩트 를 참조하십시오.

선택 사항: 플레이북 구문을 확인합니다.

# ansible-playbook --syntax-check playbook.yml인벤토리 파일에서 플레이북을 실행합니다.

# ansible-playbook -i inventory_file playbook.yml

검증

제어 노드에서

verify_playbook.yml과 같은 다른 플레이북을 생성합니다.- hosts: all tasks: - name: Verify active crypto policy include_role: name: rhel-system-roles.crypto_policies - debug: var: crypto_policies_active이 플레이북은 시스템의 구성을 변경하지 않고 관리 노드의 활성 정책만 보고합니다.

동일한 인벤토리 파일에서 플레이북을 실행합니다.

# ansible-playbook -i inventory_file verify_playbook.yml TASK [debug] ************************** ok: [host] => { "crypto_policies_active": "FUTURE" }

"crypto_policies_active":변수는 관리 노드에서 정책을 활성으로 표시합니다.

4.3. 추가 리소스

-

/usr/share/ansible/roles/rhel-system-roles.crypto_policies/README.md파일 -

ansible-playbook(1)도움말 페이지. - RHEL 시스템 역할을 사용하도록 제어 노드 및 관리형 노드 준비

5장. PKCS #11을 통해 암호화 하드웨어를 사용하도록 애플리케이션 구성

서버 애플리케이션을 위한 스마트 카드 및 암호화 토큰과 같은 전용 암호화 장치에 대한 시크릿 정보의 부분을 분리하면 서버 애플리케이션을 위한 HSM(하드웨어 보안 모듈)이 추가로 제공됩니다. RHEL에서 PKCS #11 API를 통한 암호화 하드웨어 지원은 서로 다른 애플리케이션에서 일관성이 유지되며 암호화 하드웨어에서 시크릿을 격리하는 작업이 복잡하지 않습니다.

5.1. PKCS #11을 통한 하드웨어 지원

PKI(Public-Key Cryptography Standard) #11은 암호화 정보를 유지하고 암호화 기능을 수행하는 장치를 암호화하기 위한 API(애플리케이션 프로그래밍 인터페이스)를 정의합니다.

PKCS #11에는 각 하드웨어 또는 소프트웨어 장치를 통합된 방식으로 애플리케이션에 제공하는 오브젝트인 암호화 토큰이 도입되었습니다. 따라서 애플리케이션은 일반적으로 개인에 의해 사용되는 스마트 카드와 같은 장치를 봅니다. 일반적으로 PKCS #11 암호화 토큰으로 컴퓨터에서 사용하는 하드웨어 보안 모듈입니다.

PKCS #11 토큰은 인증서, 데이터 오브젝트 및 공용, 개인 키 또는 시크릿 키를 비롯한 다양한 오브젝트 유형을 저장할 수 있습니다. 이러한 오브젝트는 PKCS #11 URI(Uniform Resource Identifier) 체계를 통해 고유하게 식별할 수 있습니다.

PKCS #11 URI는 개체 특성에 따라 PKCS #11 모듈에서 특정 오브젝트를 식별하는 표준 방법입니다. 이를 통해 URI 형식으로 동일한 구성 문자열로 모든 라이브러리 및 애플리케이션을 구성할 수 있습니다.

RHEL은 기본적으로 스마트 카드용 OpenSC PKCS #11 드라이버를 제공합니다. 그러나 하드웨어 토큰과 HSM에는 시스템에 해당되지 않는 자체 PKCS #11 모듈이 있을 수 있습니다. 시스템에서 등록된 스마트 카드 드라이버를 통해 래퍼 역할을 하는 p11-kit 도구로 이러한 PKCS #11 모듈을 등록할 수 있습니다.

고유한 PKCS #11 모듈이 시스템에서 작동하도록 하려면 새 텍스트 파일을 /etc/pkcs11/modules/ 디렉토리에 추가합니다.

/etc/pkcs11/modules/ 디렉터리에 새 텍스트 파일을 생성하여 자체 PKCS #11 모듈을 시스템에 추가할 수 있습니다. 예를 들어 p11-kit 의 OpenSC 구성 파일은 다음과 같습니다.

$ cat /usr/share/p11-kit/modules/opensc.module

module: opensc-pkcs11.so5.2. 스마트 카드에 저장된 SSH 키 사용

Red Hat Enterprise Linux를 사용하면 OpenSSH 클라이언트의 스마트 카드에 저장된 RSA 및 ECDSA 키를 사용할 수 있습니다. 다음 절차에 따라 암호 대신 스마트 카드로 인증을 활성화합니다.

사전 요구 사항

-

클라이언트 측에서

opensc패키지가 설치되고pcscd서비스가 실행 중입니다.

절차

PKCS #11 URI를 포함하여 OpenSC PKCS #11 모듈에서 제공하는 모든 키를 나열하고 출력을 keys.pub 파일에 저장합니다.

$ ssh-keygen -D pkcs11: > keys.pub $ ssh-keygen -D pkcs11: ssh-rsa AAAAB3NzaC1yc2E...KKZMzcQZzx pkcs11:id=%02;object=SIGN%20pubkey;token=SSH%20key;manufacturer=piv_II?module-path=/usr/lib64/pkcs11/opensc-pkcs11.so ecdsa-sha2-nistp256 AAA...J0hkYnnsM= pkcs11:id=%01;object=PIV%20AUTH%20pubkey;token=SSH%20key;manufacturer=piv_II?module-path=/usr/lib64/pkcs11/opensc-pkcs11.so

원격 서버(example.com)에서 스마트 카드를 사용하여 인증을 활성화하려면 공개 키를 원격 서버로 전송합니다. 이전 단계에서 만든 keys.pub와 함께

ssh-copy-id명령을 사용하십시오.$ ssh-copy-id -f -i keys.pub username@example.com1단계에서

ssh-keygen -D명령의 출력에서 ECDSA 키를 사용하여 example.com 에 연결하려면 다음과 같이 키를 고유하게 참조하는 URI의 하위 집합만 사용할 수 있습니다.$ ssh -i "pkcs11:id=%01?module-path=/usr/lib64/pkcs11/opensc-pkcs11.so" example.com Enter PIN for 'SSH key': [example.com] $~/.ssh/config파일에서 동일한 URI 문자열을 사용하여 구성을 영구적으로 만들 수 있습니다.$ cat ~/.ssh/config IdentityFile "pkcs11:id=%01?module-path=/usr/lib64/pkcs11/opensc-pkcs11.so" $ ssh example.com Enter PIN for 'SSH key': [example.com] $

OpenSSH는

p11-kit-proxy래퍼를 사용하고 OpenSC PKCS #11 모듈은 PKCS#11 Kit에 등록되므로 이전 명령을 간소화할 수 있습니다.$ ssh -i "pkcs11:id=%01" example.com Enter PIN for 'SSH key': [example.com] $

PKCS #11 URI의 id= 부분을 건너뛰면 OpenSSH는 proxy 모듈에서 사용할 수 있는 모든 키를 로드합니다. 이렇게 하면 필요한 입력 횟수가 줄어듭니다.

$ ssh -i pkcs11: example.com

Enter PIN for 'SSH key':

[example.com] $추가 리소스

- Fedora 28: OpenSSH에서 스마트 카드 지원 개선

-

p11-kit(8),opensc.conf(5),pcscd(8),ssh(1)및ssh-keygen(1)매뉴얼 페이지

5.3. 스마트 카드에서 인증서를 사용하여 인증을 위한 애플리케이션 구성

애플리케이션에서 스마트 카드를 사용하여 인증하면 보안이 향상되고 자동화가 간소화될 수 있습니다. 다음 방법을 사용하여 PKI(Public Key Cryptography Standard) #11 URI를 애플리케이션에 통합할 수 있습니다.

-

Firefox웹 브라우저에서p11-kit-proxyPKCS #11 모듈을 자동으로 로드합니다. 즉, 시스템에서 지원되는 모든 스마트 카드가 자동으로 감지됩니다. TLS 클라이언트 인증을 사용하려면 추가 설정이 필요하지 않으며 서버가 요청할 때 스마트 카드의 키와 인증서가 자동으로 사용됩니다. -

애플리케이션에서

GnuTLS또는NSS라이브러리를 사용하는 경우 PKCS #11 URI를 이미 지원합니다. 또한OpenSSL라이브러리에 의존하는 애플리케이션은openssl-pkcs11패키지에서 제공하는pkcs11엔진을 통해 스마트 카드를 포함한 암호화 하드웨어 모듈에 액세스할 수 있습니다. -

스마트 카드에서 개인 키로 작업해야 하며

NSS,GnuTLS또는OpenSSL을 사용하지 않는 애플리케이션에서는 특정 PKCS #11 모듈의 PKCS #11 API를 사용하는 대신, 스마트 카드를 포함한 암호화 하드웨어 모듈과 함께 작업하는 데 직접p11-kitAPI를 사용할 수 있습니다. wget네트워크 다운 로더를 사용하면 로컬에 저장된 개인 키 및 인증서에 대한 경로 대신 PKCS #11 URI를 지정할 수 있습니다. 이렇게 하면 안전하게 저장된 개인 키와 인증서가 필요한 작업의 스크립트 생성이 간소화될 수 있습니다. 예를 들어 다음과 같습니다.$ wget --private-key 'pkcs11:token=softhsm;id=%01;type=private?pin-value=111111' --certificate 'pkcs11:token=softhsm;id=%01;type=cert' https://example.com/curl툴을 사용할 때 PKCS #11 URI를 지정할 수도 있습니다.$ curl --key 'pkcs11:token=softhsm;id=%01;type=private?pin-value=111111' --cert 'pkcs11:token=softhsm;id=%01;type=cert' https://example.com/참고PIN은 스마트 카드에 저장된 키에 대한 액세스를 제어하는 보안 수단이고 구성 파일에 일반 텍스트 형식의 PIN이 포함되어 있으므로 공격자가 PIN을 읽지 못하도록 추가 보호를 고려하십시오. 예를 들어

pin-source속성을 사용하여file:을 제공할 수 있습니다. 파일에서 PIN을 읽기 위한 URI입니다. RFC 7512: PKCS #11 URI Scheme Query 특성 Semantics에서 자세한 내용을 확인하십시오. 명령 경로를pin-source속성 값으로 사용하는 것은 지원되지 않습니다.

추가 리소스

-

curl(1),wget(1),p11-kit(8)도움말 페이지

5.4. Apache에서 HSM을 사용하여 개인 키 보호

Apache HTTP 서버는 HSM(하드웨어 보안 모듈)에 저장된 개인 키로 작동할 수 있으므로 키 공개 및 중간자 공격을 방지하는 데 도움이 됩니다. 이 경우 일반적으로 사용 중인 서버에는 고성능 HSM이 필요합니다.

HTTPS 프로토콜 형식의 보안 통신을 위해 Apache HTTP 서버(httpd)는 OpenSSL 라이브러리를 사용합니다. OpenSSL은 기본적으로 PKCS #11을 지원하지 않습니다. HSM을 사용하려면 엔진 인터페이스를 통해 PKCS #11 모듈에 대한 액세스를 제공하는 openssl-pkcs11 패키지를 설치해야 합니다. 일반 파일 이름 대신 PKCS #11 URI를 사용하여 /etc/httpd/conf.d/ssl.conf 구성 파일에 서버 키와 인증서를 지정할 수 있습니다. 예를 들면 다음과 같습니다.

SSLCertificateFile "pkcs11:id=%01;token=softhsm;type=cert" SSLCertificateKeyFile "pkcs11:id=%01;token=softhsm;type=private?pin-value=111111"

httpd-manual 패키지를 설치하여 TLS 구성을 포함하여 Apache HTTP Server에 대한 전체 문서를 가져옵니다. /etc/httpd/conf.d/ssl.conf 구성 파일에서 사용 가능한 지시문은 /usr/share/httpd/manual/mod/mod_ssl.html 파일에 자세히 설명되어 있습니다.

5.5. Nginx에서 개인 키를 보호하는 HSM 사용

Nginx HTTP 서버는 HSM(하드웨어 보안 모듈)에 저장된 개인 키로 작동할 수 있으므로 키 공개 및 중간자 공격을 방지하는 데 도움이 됩니다. 이 경우 일반적으로 사용 중인 서버에는 고성능 HSM이 필요합니다.

Nginx는 암호화 작업에도 OpenSSL을 사용하므로 PKCS #11에 대한 지원은 openssl-pkcs11 엔진을 통과해야 합니다. Nginx는 현재 HSM에서 개인 키 로드만 지원하며 인증서는 일반 파일로 별도로 제공해야 합니다. /etc/nginx/nginx.conf 구성 파일의 server 섹션에서 ssl_certificate 및 ssl_certificate_key 옵션을 수정합니다.

ssl_certificate /path/to/cert.pem ssl_certificate_key "engine:pkcs11:pkcs11:token=softhsm;id=%01;type=private?pin-value=111111";

Nginx 구성 파일의 PKCS #11 URI에는 engine:pkcs11: 접두사가 필요합니다. 이는 다른 pkcs11 접두사가 엔진 이름을 참조하기 때문입니다.

5.6. 추가 리소스

-

pkcs11.conf(5)도움말 페이지.

6장. polkit을 사용하여 스마트 카드에 대한 액세스 제어

Pins, PIN pads 및 biometrics와 같이 스마트 카드에 내장된 메커니즘으로 방지할 수 없는 가능한 위협과 보다 세분화된 제어를 위해 RHEL은 스마트 카드에 대한 액세스 제어를 제어하기 위해 polkit 프레임워크를 사용합니다.

시스템 관리자는 권한이 없는 사용자 또는 로컬이 아닌 사용자 또는 서비스에 대한 스마트 카드 액세스와 같은 특정 시나리오에 맞게 polkit을 구성할 수 있습니다.

6.1. polkit을 통한 스마트 카드 액세스 제어

개인 컴퓨터/스마트 카드(PC/SC) 프로토콜은 스마트 카드 및 독자를 컴퓨팅 시스템에 통합하기 위한 표준을 지정합니다. RHEL에서 pcsc-lite 패키지는 PC/SC API를 사용하는 스마트 카드에 대한 미들웨어를 제공합니다. 이 패키지의 일부인 pcscd (PC/SC Smart Card) 데몬을 사용하면 시스템이 PC/SC 프로토콜을 사용하여 스마트 카드에 액세스할 수 있습니다.

Pins, PIN pads 및 biometrics와 같은 스마트 카드에 내장된 액세스 제어 메커니즘은 가능한 모든 위협을 다루지 않기 때문에 RHEL은 보다 강력한 액세스 제어를 위해 polkit 프레임워크를 사용합니다. polkit 권한 부여 관리자는 권한 있는 작업에 대한 액세스 권한을 부여할 수 있습니다. 디스크에 대한 액세스 권한을 부여하는 것 외에도 polkit 을 사용하여 스마트 카드 보안을 위한 정책을 지정할 수 있습니다. 예를 들어 스마트 카드로 작업을 수행할 수 있는 사용자를 정의할 수 있습니다.

pcsc-lite 패키지를 설치하고 pcscd 데몬을 시작한 후 시스템은 /usr/share/polkit-1/actions/ 디렉터리에 정의된 정책을 적용합니다. 기본 시스템 전체 정책은 /usr/share/polkit-1/actions/org.debian.pcsc-lite.policy 파일에 있습니다. polkit 정책 파일은 XML 형식을 사용하며 구문은 polkit(8) 도움말 페이지에 설명되어 있습니다.

polkitd 서비스는 /etc/polkit-1/rules.d/ 및 /usr/share/polkit-1/rules.d/ 디렉토리를 모니터링하여 이러한 디렉토리에 저장된 규칙 파일의 변경 사항을 모니터링합니다. 파일에는 JavaScript 형식의 권한 부여 규칙이 포함되어 있습니다. 시스템 관리자는 두 디렉토리에 모두 사용자 지정 규칙 파일을 추가할 수 있으며 polkitd 는 파일 이름을 기반으로 하여 사전순으로 읽습니다. 두 파일의 이름이 같은 경우 /etc/polkit-1/rules.d/ 의 파일이 먼저 표시됩니다.

추가 리소스

-

polkit(8),polkitd(8),pcscd(8)매뉴얼 페이지.

6.2. PC/SC 및 polkit 관련 문제 해결

pcsc-lite 패키지를 설치한 후 자동으로 시행되고 pcscd 데몬을 시작하면 사용자가 스마트 카드와 직접 상호 작용하지 않더라도 사용자 세션에서 인증을 요청할 수 있습니다. GNOME에는 다음과 같은 오류 메시지가 표시됩니다.

Authentication is required to access the PC/SC daemon

opensc 와 같은 스마트 카드 관련 다른 패키지를 설치할 때 시스템이 pcsc-lite 패키지를 종속성으로 설치할 수 있습니다.

시나리오가 스마트 카드와의 상호 작용을 필요로하지 않고 PC/SC 데몬에 대한 권한 부여 요청을 표시하지 않으려면 pcsc-lite 패키지를 제거할 수 있습니다. 필요한 최소 패키지를 유지하는 것은 어쨌든 좋은 보안 관행입니다.

스마트 카드를 사용하는 경우 /usr/share/polkit-1/actions/org.debian.pcsc-lite.policy에서 시스템 제공 정책 파일에서 규칙을 확인하여 문제 해결을 시작합니다. /etc/polkit-1/rules.d/ 디렉터리(예: 03-allow-pcscd.rules )의 정책에 사용자 지정 규칙 파일을 추가할 수 있습니다. 규칙 파일은 JavaScript 구문을 사용하며 정책 파일은 XML 형식으로 되어 있습니다.

시스템이 표시하는 권한 부여 요청을 이해하려면 저널 로그를 확인합니다. 예를 들면 다음과 같습니다.

$ journalctl -b | grep pcsc

...

Process 3087 (user: 1001) is NOT authorized for action: access_pcsc

...

이전 로그 항목은 사용자가 정책에 의해 작업을 수행할 수 있는 권한이 없음을 의미합니다. /etc/polkit-1/rules.d/ 에 해당 규칙을 추가하여 이 거부를 해결할 수 있습니다.

polkitd 유닛과 관련된 로그 항목을 검색할 수도 있습니다. 예를 들면 다음과 같습니다.

$ journalctl -u polkit

...

polkitd[NNN]: Error compiling script /etc/polkit-1/rules.d/00-debug-pcscd.rules

...

polkitd[NNN]: Operator of unix-session:c2 FAILED to authenticate to gain authorization for action org.debian.pcsc-lite.access_pcsc for unix-process:4800:14441 [/usr/libexec/gsd-smartcard] (owned by unix-user:group)

...

이전 출력에서 첫 번째 항목은 규칙 파일에 일부 구문 오류가 있음을 나타냅니다. 두 번째 항목은 사용자가 pcscd에 대한 액세스 권한을 얻지 못했음을 의미합니다.

또한 짧은 스크립트로 PC/SC 프로토콜을 사용하는 모든 애플리케이션을 나열할 수 있습니다. 실행 가능한 파일(예: pcsc-apps.sh )을 생성하고 다음 코드를 삽입합니다.

#!/bin/bash cd /proc for p in [0-9]* do if grep libpcsclite.so.1.0.0 $p/maps &> /dev/null then echo -n "process: " cat $p/cmdline echo " ($p)" fi done

스크립트를 root로 실행합니다.

# ./pcsc-apps.sh

process: /usr/libexec/gsd-smartcard (3048)

enable-sync --auto-ssl-client-auth --enable-crashpad (4828)

...추가 리소스

-

journalctl,polkit(8),polkitd(8)및pcscd(8)메뉴얼 페이지.

6.3. PC/SC에 대한 polkit 권한에 대한 자세한 정보 표시

기본 구성에서 polkit 권한 부여 프레임워크는 저널 로그에 제한된 정보만 보냅니다. 새 규칙을 추가하여 PC/SC 프로토콜과 관련된 polkit 로그 항목을 확장할 수 있습니다.

사전 요구 사항

-

시스템에

pcsc-lite패키지를 설치했습니다. -

pcscd데몬이 실행 중입니다.

절차

/etc/polkit-1/rules.d/디렉토리에 새 파일을 생성합니다.# touch /etc/polkit-1/rules.d/00-test.rules선택한 편집기에서 파일을 편집합니다. 예를 들면 다음과 같습니다.

# vi /etc/polkit-1/rules.d/00-test.rules다음 행을 삽입합니다.

polkit.addRule(function(action, subject) { if (action.id == "org.debian.pcsc-lite.access_pcsc" || action.id == "org.debian.pcsc-lite.access_card") { polkit.log("action=" + action); polkit.log("subject=" + subject); } });파일을 저장하고 편집기를 종료합니다.

pcscd및polkit서비스를 다시 시작합니다.# systemctl restart pcscd.service pcscd.socket polkit.service

검증

-

pcscd에 대한 권한 부여 요청을 만듭니다. 예를 들어 Firefox 웹 브라우저를 열거나opensc패키지에서 제공하는pkcs11-tool -L명령을 사용합니다. 확장 로그 항목을 표시합니다. 예를 들면 다음과 같습니다.

# journalctl -u polkit --since "1 hour ago" polkitd[1224]: <no filename>:4: action=[Action id='org.debian.pcsc-lite.access_pcsc'] polkitd[1224]: <no filename>:5: subject=[Subject pid=2020481 user=user' groups=user,wheel,mock,wireshark seat=null session=null local=true active=true]

추가 리소스

-

polkit(8)및polkitd(8)메뉴얼 페이지.

6.4. 추가 리소스

- 스마트 카드에 대한 액세스 제어 Red Hat 블로그 문서.

7장. 구성 준수 및 취약성에 대한 시스템 검사

규정 준수 감사는 지정된 오브젝트가 규정 준수 정책에 지정된 모든 규칙을 따르는지 여부를 결정하는 프로세스입니다. 규정 준수 정책은 컴퓨팅 환경에서 사용해야 하는 체크리스트 형태로 필요한 설정을 지정하는 보안 전문가가 정의합니다.

규정 준수 정책은 조직마다, 심지어 동일한 조직 내의 여러 시스템에서도 크게 달라질 수 있습니다. 이러한 정책의 차이는 각 시스템의 목적과 조직의 중요성을 기반으로 합니다. 사용자 지정 소프트웨어 설정 및 배포 특성으로 인해 사용자 지정 정책 체크리스트가 필요합니다.

7.1. RHEL의 구성 준수 도구

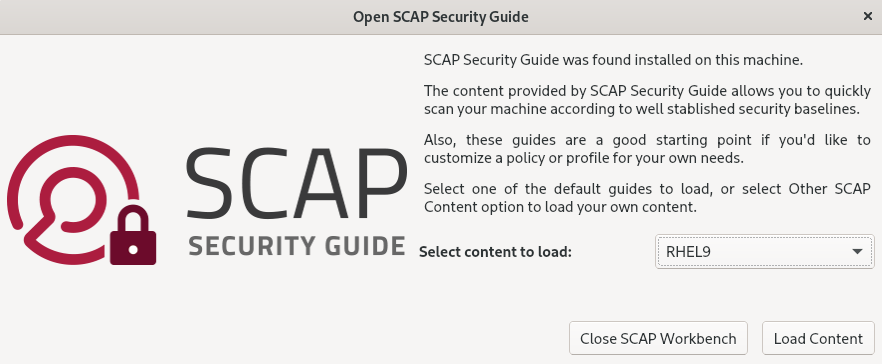

다음 구성 규정 준수 툴을 사용하여 Red Hat Enterprise Linux에서 완전히 자동화된 규정 준수 감사를 수행할 수 있습니다. 이러한 툴은 SCAP(Security Content Automation Protocol) 표준을 기반으로 하며 규정 준수 정책의 자동화된 조정을 위해 설계되었습니다.

- SCAP Workbench

-

scap-workbench그래픽 유틸리티는 단일 로컬 또는 원격 시스템에서 구성 및 취약점 검사를 수행하도록 설계되었습니다. 또한 이러한 스캔 및 평가를 기반으로 보안 보고서를 생성하는 데 사용할 수도 있습니다. - OpenSCAP

oscap명령줄 유틸리티가 포함된OpenSCAP라이브러리는 로컬 시스템에서 구성 및 취약점 검사를 수행하고 구성 규정 준수 콘텐츠를 검증하고 이러한 검사 및 평가를 기반으로 보고서 및 가이드를 생성하도록 설계되었습니다.중요OpenSCAP 을 사용하는 동안 메모리 사용량 문제가 발생할 수 있으므로 프로그램을 조기 중단하고 결과 파일이 생성되지 않을 수 있습니다. 자세한 내용은 OpenSCAP 메모리 사용 문제 지식 베이스 문서를 참조하십시오.

- SCAP Security Guide (SSG)

-

scap-security-guide패키지는 Linux 시스템에 대한 최신 보안 정책 컬렉션을 제공합니다. 이 지침은 적용 가능한 경우 정부 요구 사항과 연결된 실용적인 강화 조언 카탈로그로 구성됩니다. 이 프로젝트는 일반화된 정책 요구 사항과 특정 구현 지침 간의 격차를 해소합니다. - 스크립트 검사 엔진(SCE)

-

SCAP 프로토콜에 대한 확장인 SCE를 사용하면 관리자가 Bash, Python, Ruby와 같은 스크립팅 언어를 사용하여 보안 콘텐츠를 작성할 수 있습니다. SCE 확장은

openscap-engine-sce패키지에 제공됩니다. SCE 자체는 SCAP 표준의 일부가 아닙니다.

여러 시스템에서 원격으로 자동화된 규정 준수 감사를 수행하려면 Red Hat Satellite에 OpenSCAP 솔루션을 사용할 수 있습니다.

추가 리소스

-

oscap(8),scap-workbench(8)및scap-security-guide(8)도움말 페이지 - Red Hat 보안 데모: 으로 보안 준수 자동화를 위한 사용자 지정된 보안 정책 콘텐츠 생성

- Red Hat 보안 데모: RHEL 보안 기술로 자체 방어

- Red Hat Satellite 관리 가이드의 보안 준수 관리 가이드.

7.2. 취약점 검사

7.2.1. Red Hat 보안 공지 OVAL 피드

Red Hat Enterprise Linux 보안 감사 기능은 SCAP(Security Content Automation Protocol) 표준을 기반으로 합니다. SCAP는 자동화된 구성, 취약점 및 패치 검사, 기술 제어 준수 활동 및 보안 측정을 지원하는 다용도 사양 프레임워크입니다.

SCAP 사양은 스캐너 또는 정책 편집기를 구현하지 않아도 보안 콘텐츠 형식이 잘 알려져 표준화되어 있는 에코시스템을 생성합니다. 이를 통해 조직은 채택한 보안 벤더 수에 관계없이 SCC(보안 정책)를 한 번 구축할 수 있습니다.

OVAL(Open Vulnerability Assessment Language)은 SCAP에서 필수적이고 오래된 구성 요소입니다. 다른 툴 및 사용자 지정 스크립트와 달리 OVAL은 선언적 방식으로 필요한 리소스 상태를 설명합니다. OVAL 코드는 직접 실행되지 않지만 scanner라는 OVAL 인터프리터 툴을 사용합니다. OVAL의 선언적 특성은 평가된 시스템의 상태가 실수로 수정되지 않도록 합니다.

다른 모든 SCAP 구성 요소와 마찬가지로, OVAL은 XML을 기반으로 합니다. SCAP 표준은 여러 문서 형식을 정의합니다. 각각 다른 유형의 정보를 포함하며 다른 목적을 제공합니다.

Red Hat Product Security 는 Red Hat 고객에게 영향을 미치는 모든 보안 문제를 추적하고 조사하여 고객이 위험을 평가하고 관리할 수 있도록 지원합니다. Red Hat 고객 포털에서 적시에 간결한 패치와 보안 공지를 제공합니다. Red Hat은 OVAL 패치 정의를 생성 및 지원하여 시스템에서 읽을 수 있는 보안 권고 버전을 제공합니다.

플랫폼, 버전 및 기타 요인 간의 차이로 인해 취약점의 Red Hat 제품 보안 질적 심각도 등급은 타사에서 제공하는 CVSS(Common Vulnerability Scoring System) 기준 평가와 직접적으로 일치하지 않습니다. 따라서 타사가 제공하는 정의 대신 RHSA OVAL 정의를 사용하는 것이 좋습니다.

RHSA OVAL 정의는 개별적으로 및 전체 패키지로 사용할 수 있으며 Red Hat 고객 포털에서 사용할 수 있는 새 보안 권고를 1시간 이내에 업데이트합니다.

각 OVAL 패치 정의는 일대일로 Red Hat 보안 권고(RHSA)에 매핑됩니다. RHSA에는 여러 취약점에 대한 수정 사항이 포함될 수 있으므로 각 취약점은 CVE(Common Vulnerabilities and Exposures) 이름으로 별도로 나열되며 공개 버그 데이터베이스에 해당 항목에 대한 링크가 있습니다.

RHSA OVAL 정의는 시스템에 설치된 취약한 버전의 RPM 패키지를 확인하도록 설계되었습니다. 예를 들어 이러한 정의를 확장하여 추가 검사를 포함하여 패키지가 취약한 구성에서 사용 중인지 확인할 수 있습니다. 이러한 정의는 Red Hat이 제공하는 소프트웨어 및 업데이트를 포괄하도록 설계되었습니다. 타사 소프트웨어의 패치 상태를 감지하려면 추가 정의가 필요합니다.

Red Hat Enterprise Linux 규정 준수 서비스를 위한 Red Hat Insights는 IT 보안 및 규정 준수 관리자가 Red Hat Enterprise Linux 시스템의 보안 정책 준수를 평가, 모니터링 및 보고할 수 있도록 지원합니다. 규정 준수 서비스 UI 내에서 SCAP 보안 정책을 완전히 생성하고 관리할 수도 있습니다.

7.2.2. 시스템에서 취약점 스캔

oscap 명령줄 유틸리티를 사용하면 로컬 시스템을 스캔하고, 구성 준수 콘텐츠를 검증하고, 이러한 스캔 및 평가를 기반으로 보고서 및 가이드를 생성할 수 있습니다. 이 유틸리티는 OpenSCAP 라이브러리의 프런트엔드 역할을 하며 처리하는 SCAP 콘텐츠 유형에 따라 해당 기능을 모듈(하위 명령)에 그룹화합니다.

사전 요구 사항

-

openscap-scanner및0.0/162패키지를 설치합니다.

절차

시스템에 대한 최신 RHSA OVAL 정의를 다운로드합니다.

# wget -O - https://www.redhat.com/security/data/oval/v2/RHEL9/rhel-9.oval.xml.bz2 | bzip2 --decompress > rhel-9.oval.xml시스템에서 취약점을 스캔하고 결과를 vulnerability.html 파일에 저장합니다.

# oscap oval eval --report vulnerability.html rhel-9.oval.xml

검증

선택한 브라우저의 결과를 확인합니다. 예를 들면 다음과 같습니다.

$ firefox vulnerability.html &

추가 리소스

-

oscap(8)도움말 페이지 - Red Hat OVAL 정의

- OpenSCAP 메모리 사용 문제

7.2.3. 원격 시스템에서 취약점 스캔

SSH 프로토콜을 통해 oscap-ssh 도구를 사용하여 OpenSCAP 스캐너가 있는 취약점이 원격 시스템에 있는지 확인할 수도 있습니다.

사전 요구 사항

-

스캔에 사용하는 시스템에

openscap-utils및bzip2패키지가 설치되어 있습니다. -

openscap-scanner패키지는 원격 시스템에 설치됩니다. - SSH 서버는 원격 시스템에서 실행되고 있습니다.

절차

시스템에 대한 최신 RHSA OVAL 정의를 다운로드합니다.

# wget -O - https://www.redhat.com/security/data/oval/v2/RHEL9/rhel-9.oval.xml.bz2 | bzip2 --decompress > rhel-9.oval.xmlmachine1 호스트 이름으로 원격 시스템을 스캔하고, 포트 22에서 SSH를 실행하고, joesec 사용자 이름을 사용하여 취약점을 검사하고 결과를 remote-vulnerability.html 파일에 저장합니다.

# oscap-ssh joesec@machine1 22 oval eval --report remote-vulnerability.html rhel-9.oval.xml

추가 리소스

-

oscap-ssh(8) - Red Hat OVAL 정의

- OpenSCAP 메모리 사용 문제

7.3. 구성 규정 준수 검사

7.3.1. RHEL의 구성 규정 준수

구성 규정 준수 스캔을 사용하여 특정 조직에서 정의한 기준을 준수할 수 있습니다. 예를 들어, 미국 정부와 협력하는 경우 시스템을 OSPP(운영 체제 보호 프로필)에 맞춰야 할 수 있으며 결제 프로세서인 경우 시스템을 PCI-DSS(Payment Card Industry Data Security Standard)에 맞춰 조정해야 할 수 있습니다. 구성 준수 스캔을 수행하여 시스템 보안을 강화할 수도 있습니다.

영향을 받는 구성 요소에 대한 Red Hat 모범 사례에 부합하므로 SCAP Security Guide 패키지에 제공된 SCAP(Security Content Automation Protocol) 콘텐츠를 따르는 것이 좋습니다.

SCAP 보안 가이드 패키지는 SCAP 1.2 및 SCAP 1.3 표준을 준수하는 콘텐츠를 제공합니다. openscap 스캐너 유틸리티는 SCAP 보안 가이드 패키지에 제공된 SCAP 1.2 및 SCAP 1.3 콘텐츠와 호환됩니다.

구성 규정 준수 스캔을 수행해도 시스템이 규정을 준수하는 것은 아닙니다.

SCAP 보안 가이드 제품군은 여러 플랫폼의 프로필을 데이터 스트림 문서 형태로 제공합니다. 데이터 스트림은 정의, 벤치마크, 프로필 및 개별 규칙이 포함된 파일입니다. 각 규칙은 규정 준수에 대한 적용 가능성 및 요구 사항을 지정합니다. RHEL에서는 보안 정책을 준수하기 위해 여러 프로필을 제공합니다. 업계 표준 외에도 Red Hat 데이터 스트림에는 실패한 규칙의 수정에 대한 정보도 포함되어 있습니다.

컴플라이언스 검사 리소스 구조

Data stream ├── xccdf | ├── benchmark | ├── profile | | ├──rule reference | | └──variable | ├── rule | ├── human readable data | ├── oval reference ├── oval ├── ocil reference ├── ocil ├── cpe reference └── cpe └── remediation

프로필은 OSPP, PCI-DSS 및 HIPAA(Health Insurance Portability and Accountability Act)와 같은 보안 정책을 기반으로 하는 규칙 집합입니다. 이를 통해 보안 표준을 준수하는 자동화된 방식으로 시스템을 감사할 수 있습니다.

프로필을 수정하여 특정 규칙(예: 암호 길이)을 사용자 지정할 수 있습니다. 프로필 맞춤에 대한 자세한 내용은 SCAP Workbench를 사용하여 보안 프로필 사용자 지정을 참조하십시오.

7.3.2. OpenSCAP 스캔의 가능한 결과

OpenSCAP 스캔에 적용되는 데이터 스트림 및 프로필과 시스템의 다양한 속성에 따라 각 규칙이 특정 결과를 생성할 수 있습니다. 이러한 결과는 그 의미에 대한 간략한 설명과 함께 가능한 결과입니다.

- 통과

- 검사에서 이 규칙과의 충돌을 찾지 못했습니다.

- 실패

- 검사에서 이 규칙과 충돌하는 것을 발견했습니다.

- 확인되지 않음

- OpenSCAP에서는 이 규칙을 자동으로 평가하지 않습니다. 시스템이 이 규칙을 수동으로 준수하는지 확인합니다.

- 해당 없음

- 이 규칙은 현재 구성에 적용되지 않습니다.

- 선택되지 않음

- 이 규칙은 프로필에 포함되지 않습니다. OpenSCAP은 이 규칙을 평가하지 않으며 결과에 이러한 규칙을 표시하지 않습니다.

- 오류

-

검사에 오류가 발생했습니다. 자세한 내용은

--verbose DEVEL옵션을 사용하여oscap명령을 입력할 수 있습니다. 버그 보고서를 작성하는 것이 좋습니다. - 알 수 없음

-

검사에 예기치 않은 상황이 발생했습니다. 자세한 내용은

'--verbose DEVEL옵션을 사용하여oscap명령을 입력합니다. 버그 보고서를 작성하는 것이 좋습니다.

7.3.3. 구성 규정 준수 프로필 보기

검사 또는 수정을 위해 프로필을 사용하기 전에 나열한 후 oscap info 하위 명령을 사용하여 자세한 설명을 확인할 수 있습니다.

사전 요구 사항

-

openscap-scanner및scap-security-guide패키지가 설치됩니다.

절차

SCAP 보안 가이드 프로젝트에서 제공하는 보안 준수 프로필이 있는 사용 가능한 모든 파일을 나열합니다.

$ ls /usr/share/xml/scap/ssg/content/ ssg-rhel9-ds.xmloscap info하위 명령을 사용하여 선택한 데이터 스트림에 대한 세부 정보를 표시합니다. 데이터 스트림을 포함하는 XML 파일은 이름에-ds문자열로 표시됩니다.Profiles섹션에서 사용 가능한 프로필 및 해당 ID 목록을 찾을 수 있습니다.$ oscap info /usr/share/xml/scap/ssg/content/ssg-rhel9-ds.xml Profiles: ... Title: Australian Cyber Security Centre (ACSC) Essential Eight Id: xccdf_org.ssgproject.content_profile_e8 Title: Health Insurance Portability and Accountability Act (HIPAA) Id: xccdf_org.ssgproject.content_profile_hipaa Title: PCI-DSS v3.2.1 Control Baseline for Red Hat Enterprise Linux 9 Id: xccdf_org.ssgproject.content_profile_pci-dss ...데이터 스트림 파일에서 프로필을 선택하고 선택한 프로필에 대한 추가 세부 정보를 표시합니다. 이렇게 하려면

--profile옵션 다음에 이전 명령의 출력에 표시된 ID의 마지막 섹션과 함께oscap info를 사용합니다. 예를 들어 HIPPA 프로필의 ID는xccdf_org.ssgproject.content_profile_hipaa이고--profile옵션의 값은hipaa입니다.$ oscap info --profile hipaa /usr/share/xml/scap/ssg/content/ssg-rhel9-ds.xml ... Profile Title: [RHEL9 DRAFT] Health Insurance Portability and Accountability Act (HIPAA) Id: xccdf_org.ssgproject.content_profile_hipaa Description: The HIPAA Security Rule establishes U.S. national standards to protect individuals’ electronic personal health information that is created, received, used, or maintained by a covered entity. The Security Rule requires appropriate administrative, physical and technical safeguards to ensure the confidentiality, integrity, and security of electronic protected health information. This profile configures Red Hat Enterprise Linux 9 to the HIPAA Security Rule identified for securing of electronic protected health information. Use of this profile in no way guarantees or makes claims against legal compliance against the HIPAA Security Rule(s).

추가 리소스

-

scap-security-guide(8)도움말 페이지 - OpenSCAP 메모리 사용 문제

7.3.4. 특정 기준의 구성 준수 평가

시스템이 특정 기준을 준수하는지 확인하려면 다음 단계를 따르십시오.

사전 요구 사항

-

openscap-scanner및scap-security-guide패키지가 설치되어 있습니다. - 시스템이 준수해야 하는 기준 내에서 프로필의 ID를 알고 있습니다. ID를 찾으려면 구성 규정 준수에 대한 프로필 보기를 참조하십시오.

절차

선택한 프로필로 시스템의 컴플라이언스를 평가하고 검사 결과를 report.html HTML 파일에 저장합니다. 예를 들면 다음과 같습니다.

$ oscap xccdf eval --report report.html --profile hipaa /usr/share/xml/scap/ssg/content/ssg-rhel9-ds.xml선택 사항:

machine1호스트 이름으로 원격 시스템을 스캔하고, 포트22에서 SSH를 실행하고,joesec사용자 이름을 사용하여 규정 준수를 검색하고 결과를remote-report.html파일에 저장합니다.$ oscap-ssh joesec@machine1 22 xccdf eval --report remote_report.html --profile hipaa /usr/share/xml/scap/ssg/content/ssg-rhel9-ds.xml

추가 리소스

-

scap-security-guide(8)도움말 페이지 -

/usr/share/doc/scap-security-guide/디렉터리에 있는SCAP 보안 가이드문서 -

/usr/share/doc/scap-security-guide/guides/ssg-rhel9-guide-index.html- [Guide to the Secure Configuration of Red Hat Enterprise Linux 9] installed with thescap-security-guide-docpackage. - OpenSCAP 메모리 사용 문제

7.4. 특정 기준선에 맞게 시스템 수정

특정 기준선에 맞게 RHEL 시스템을 수정할 수 있습니다. 이 예에서는 HIPAA(Health Insurance Portability and Accountability Act) 프로필을 사용하지만 SCAP 보안 가이드에서 제공하는 다른 프로필과 일치하도록 수정할 수 있습니다. 사용 가능한 프로필 나열에 대한 자세한 내용은 구성 규정 준수에 대한 프로필 보기 섹션을 참조하십시오.

신중하게 사용하지 않는 경우 Remediate 옵션을 활성화하여 시스템 평가를 실행하면 시스템에 작동하지 않을 수 있습니다. Red Hat은 보안 강화 수정으로 인한 변경 사항을 되돌릴 수 있는 자동화된 방법을 제공하지 않습니다. 수정은 기본 구성의 RHEL 시스템에서 지원됩니다. 설치 후 시스템이 변경된 경우 수정을 실행하여 필요한 보안 프로필을 준수하지 못할 수 있습니다.

사전 요구 사항

-

scap-security-guide패키지가 RHEL 시스템에 설치되어 있습니다.

절차

--remediate옵션과 함께oscap명령을 사용합니다.# oscap xccdf eval --profile hipaa --remediate /usr/share/xml/scap/ssg/content/ssg-rhel9-ds.xml- 시스템을 다시 시작합니다.

검증

HIPAA 프로파일로 시스템 규정 준수를 평가하고

hipaa_report.html파일에 검사 결과를 저장합니다.$ oscap xccdf eval --report hipaa_report.html --profile hipaa /usr/share/xml/scap/ssg/content/ssg-rhel9-ds.xml

추가 리소스

-

scap-security-guide(8)및oscap(8)도움말 페이지

7.5. SSG Ansible 플레이북을 사용하여 특정 기준과 일치하도록 시스템 수정

SCAP 보안 가이드 프로젝트의 Ansible 플레이북 파일을 사용하여 특정 기준과 일치하도록 시스템을 교정할 수 있습니다. 이 예에서는 HIPAA(Health Insurance Portability and Accountability Act) 프로필을 사용하지만 SCAP 보안 가이드에서 제공하는 다른 프로필과 일치하도록 수정할 수 있습니다. 사용 가능한 프로필 나열에 대한 자세한 내용은 구성 규정 준수에 대한 프로필 보기 섹션을 참조하십시오.

신중하게 사용하지 않는 경우 Remediate 옵션을 활성화하여 시스템 평가를 실행하면 시스템에 작동하지 않을 수 있습니다. Red Hat은 보안 강화 수정으로 인한 변경 사항을 되돌릴 수 있는 자동화된 방법을 제공하지 않습니다. 수정은 기본 구성의 RHEL 시스템에서 지원됩니다. 설치 후 시스템이 변경된 경우 수정을 실행하여 필요한 보안 프로필을 준수하지 못할 수 있습니다.

사전 요구 사항

-

scap-security-guide패키지가 설치됩니다. -

ansible-core패키지가 설치되어 있습니다. 자세한 내용은 Ansible 설치 가이드를 참조하십시오.

RHEL 8.6 이상에서는 Ansible Engine이 기본 제공 모듈만 포함된 ansible-core 패키지로 교체됩니다. 많은 Ansible 수정에서는 기본 제공 모듈에 포함되지 않은 커뮤니티 및 이식 가능한 운영 체제 인터페이스(POSIX) 컬렉션의 모듈을 사용합니다. 이 경우 Bash 수정을 Ansible 수정을 대신 사용할 수 있습니다. RHEL 9의 Red Hat Connector에는 해결 플레이북이 Ansible Core에서 작동할 수 있도록 하는 데 필요한 Ansible 모듈이 포함되어 있습니다.

절차

Ansible을 사용하여 HIPAA에 맞게 시스템을 교정합니다.

# ansible-playbook -i localhost, -c local /usr/share/scap-security-guide/ansible/rhel9-playbook-hipaa.yml- 시스템을 다시 시작합니다.

검증

HIPAA 프로파일로 시스템 규정 준수를 평가하고

hipaa_report.html파일에 검사 결과를 저장합니다.# oscap xccdf eval --profile hipaa --report hipaa_report.html /usr/share/xml/scap/ssg/content/ssg-rhel9-ds.xml

추가 리소스

-

scap-security-guide(8)및oscap(8)도움말 페이지 - Ansible 설명서

7.6. 시스템을 특정 기준과 정렬하도록 수정 Ansible 플레이북 생성

시스템을 특정 기준과 조정하는 데 필요한 수정 사항만 포함하는 Ansible 플레이북을 생성할 수 있습니다. 이 예에서는 HIPAA(Health Insurance Portability and Accountability Act) 프로필을 사용합니다. 이 절차를 통해 이미 충족된 요구 사항을 다루지 않는 작은 플레이북을 생성합니다. 이러한 단계를 수행하면 시스템을 어떤 식으로든 수정하지 않으며 이후 애플리케이션을 위한 파일만 준비합니다.

RHEL 9에서는 Ansible Engine이 내장된 모듈만 포함하는 ansible-core 패키지로 교체됩니다. 많은 Ansible 수정에서는 기본 제공 모듈에 포함되지 않은 커뮤니티 및 이식 가능한 운영 체제 인터페이스(POSIX) 컬렉션의 모듈을 사용합니다. 이 경우 Bash 수정을 Ansible 수정을 대신 사용할 수 있습니다. RHEL 9.0의 Red Hat Connector에는 해결 플레이북이 Ansible Core에서 작동할 수 있도록 하는 데 필요한 Ansible 모듈이 포함되어 있습니다.

사전 요구 사항

-

scap-security-guide패키지가 설치됩니다.

절차

시스템을 스캔하고 결과를 저장합니다.

# oscap xccdf eval --profile hipaa --results <hipaa-results.xml> /usr/share/xml/scap/ssg/content/ssg-rhel9-ds.xml결과를 사용하여 파일에서 결과 ID 값을 찾습니다.

# oscap info <hipaa-results.xml>1단계에서 생성된 파일을 기반으로 Ansible 플레이북을 생성합니다.

# oscap xccdf generate fix --fix-type ansible --result-id <xccdf_org.open-scap_testresult_xccdf_org.ssgproject.content_profile_hipaa> --output <hipaa-remediations.yml> <hipaa-results.xml>-

1단계에서 수행한 검사 중에 실패한 규칙에 대한 Ansible 수정이 포함된 생성된 파일을 검토합니다. 생성된 이 파일을 검토한 후

ansible-playbook < hipaa-remediations.yml> 명령을 사용하여 적용할 수 있습니다.

검증

-

선택한 텍스트 편집기에서 생성된 <

hipaa-remediations.yml> 파일에 1단계에서 수행한 검사에 실패한 규칙이 포함되어 있는지 검토합니다.

추가 리소스

-

scap-security-guide(8)및oscap(8)도움말 페이지 - Ansible 설명서

7.7. 이후 애플리케이션에 대한 해결 Bash 스크립트 생성

이 절차를 사용하여 시스템을 HIPAA와 같은 보안 프로필에 정렬하는 수정이 포함된 Bash 스크립트를 생성합니다. 다음 단계를 사용하여 시스템을 수정하지 않고 이후 애플리케이션을 위한 파일만 준비합니다.

사전 요구 사항

-

scap-security-guide패키지가 RHEL 시스템에 설치되어 있습니다.

절차

oscap명령을 사용하여 시스템을 스캔하고 결과를 XML 파일에 저장합니다. 다음 예에서oscap은hipaa프로필에 대해 시스템을 평가합니다.# oscap xccdf eval --profile hipaa --results <hipaa-results.xml> /usr/share/xml/scap/ssg/content/ssg-rhel9-ds.xml결과를 사용하여 파일에서 결과 ID 값을 찾습니다.

# oscap info <hipaa-results.xml>1단계에서 생성된 결과 파일을 기반으로 Bash 스크립트를 생성합니다.

# oscap xccdf generate fix --fix-type bash --result-id <xccdf_org.open-scap_testresult_xccdf_org.ssgproject.content_profile_hipaa> --output <hipaa-remediations.sh> <hipaa-results.xml>-

&

lt;hipaa-remediations.sh> 파일에는 1단계에서 수행한 검사 중에 실패한 규칙에 대한 수정이 포함되어 있습니다. 생성된 이 파일을 검토한 후 이 파일과 동일한 디렉터리에 있는 경우./ <hipaa-remediations.sh> 명령으로 적용할 수 있습니다.

검증

-

선택한 텍스트 편집기에서 <

hipaa-remediations.sh> 파일에 1단계에서 수행한 검사에 실패한 규칙이 포함되어 있는지 검토합니다.

추가 리소스

-

scap-security-guide(8),oscap(8)및bash(1)도움말 페이지

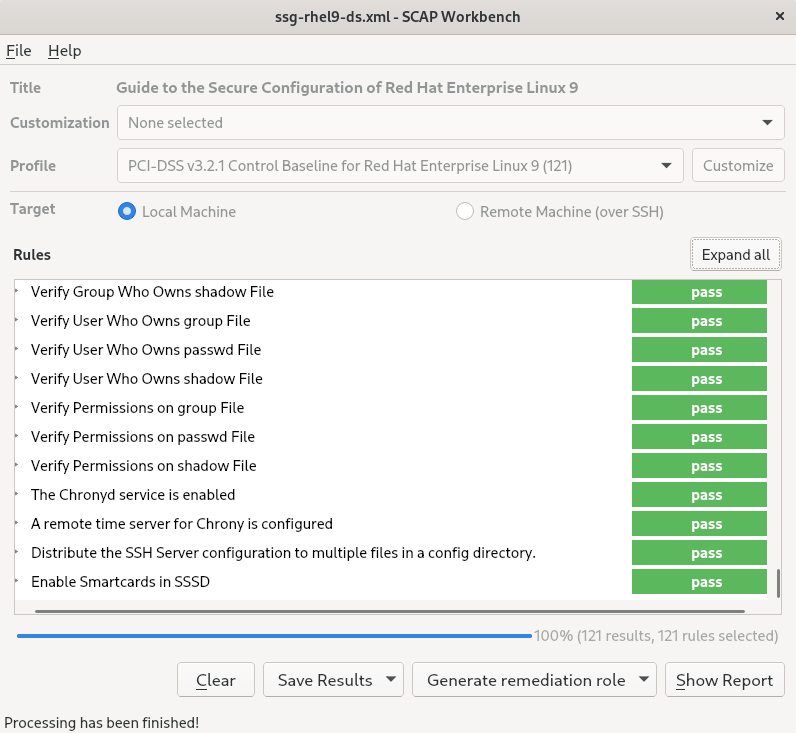

7.8. SCAP Workbench를 사용하여 사용자 지정 프로필로 시스템 검사

scap-workbench 패키지에 포함된 SCAP Workbench는 사용자가 단일 로컬 또는 원격 시스템에서 구성 및 취약점 검사를 수행하고 시스템 수정을 수행하고 스캔 평가를 기반으로 보고서를 생성하는 그래픽 유틸리티입니다. SCAP Workbench에는 oscap 명령줄 유틸리티에 비해 기능이 제한되어 있습니다. SCAP Workbench 는 데이터 스트림 파일 형식으로 보안 콘텐츠를 처리합니다.

7.8.1. SCAP Workbench를 사용하여 시스템 검사 및 수정

선택한 보안 정책에 대해 시스템을 평가하려면 다음 절차를 사용합니다.

사전 요구 사항

-

scap-workbench패키지가 시스템에 설치되어 있습니다.

절차

GNOME Classic데스크탑 환경에서SCAP Workbench를 실행하려면 Super 키를 눌러Activities Overview를 입력하고scap-workbench를 입력한 다음 Enter 키를 누릅니다. 또는 다음을 사용합니다.$ scap-workbench &다음 옵션 중 하나를 사용하여 보안 정책을 선택합니다.

-

시작 창에서

콘텐츠 로드버튼 -

SCAP 보안 가이드에서 콘텐츠 열기 File(파일) 메뉴에서기타 콘텐츠를 열고해당 XCCDF, SCAP RPM 또는 데이터 스트림 파일을 검색합니다.

-

시작 창에서

Remediate 확인란을 선택하여 시스템 구성을 자동으로 수정할 수 있습니다. 이 옵션을 활성화하면

SCAP Workbench는 정책에서 적용하는 보안 규칙에 따라 시스템 구성을 변경합니다. 이 프로세스는 시스템 검사 중에 실패하는 관련 검사를 수정해야 합니다.주의신중하게 사용하지 않는 경우

Remediate옵션을 활성화하여 시스템 평가를 실행하면 시스템에 작동하지 않을 수 있습니다. Red Hat은 보안 강화 수정으로 인한 변경 사항을 되돌릴 수 있는 자동화된 방법을 제공하지 않습니다. 수정은 기본 구성의 RHEL 시스템에서 지원됩니다. 설치 후 시스템이 변경된 경우 수정을 실행하여 필요한 보안 프로필을 준수하지 못할 수 있습니다.Scan 버튼을 클릭하여 선택한 프로필로 시스템을 스캔합니다.

-

검사 결과를 XCCDF, ARF 또는 HTML 파일의 형식으로 저장하려면 Save Results 콤보 상자를 클릭합니다.

HTML Report옵션을 선택하여 사용자가 읽을 수 있는 형식으로 스캔 보고서를 생성합니다. XCCDF 및 ARF(데이터 스트림) 형식은 추가 자동 처리에 적합합니다. 세 가지 옵션을 모두 반복적으로 선택할 수 있습니다. - 결과 기반 수정을 파일로 내보내려면 Generate remediation 역할 팝업 메뉴를 사용합니다.

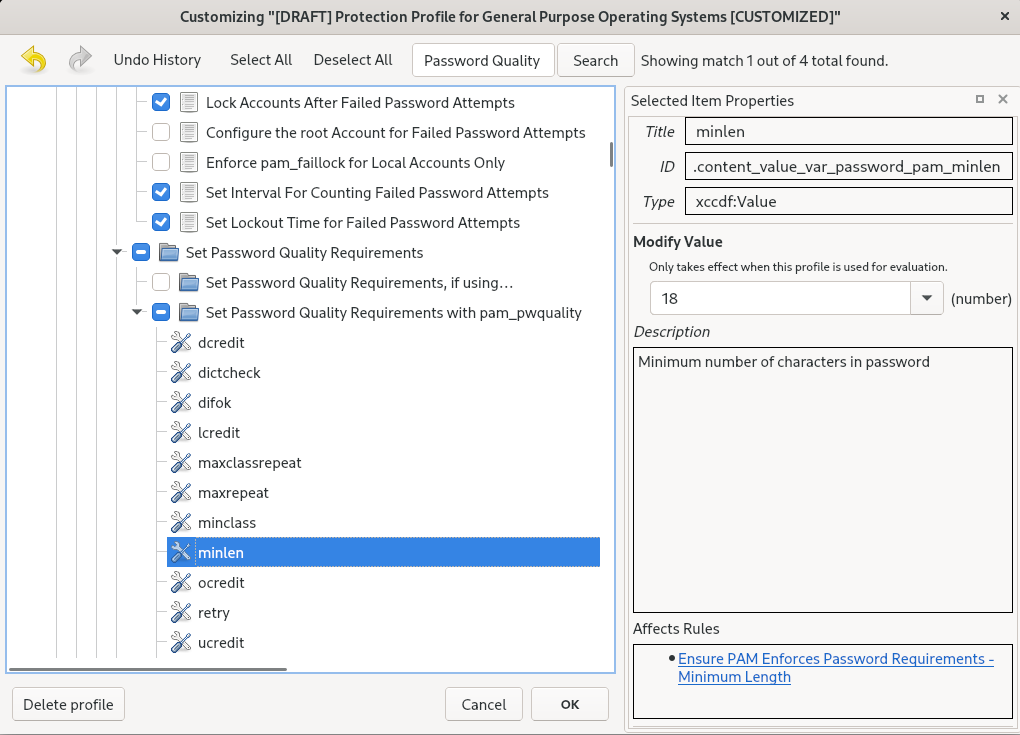

7.8.2. SCAP Workbench를 사용하여 보안 프로필 사용자 정의

특정 규칙(예: 최소 암호 길이)에서 매개 변수를 변경하고, 다른 방식으로 적용되는 규칙을 제거하고 추가 규칙을 선택하여 내부 정책을 구현하여 보안 프로필을 사용자 지정할 수 있습니다. 프로필을 사용자 지정하여 새 규칙을 정의할 수 없습니다.

다음 절차에서는 프로필을 사용자 지정하는 데 SCAP Workbench를 사용하는 방법을 보여줍니다. oscap 명령줄 유틸리티와 함께 사용할 맞춤형 프로필을 저장할 수도 있습니다.

사전 요구 사항

-

scap-workbench패키지가 시스템에 설치되어 있습니다.

절차

-

SCAP Workbench를 실행하고File메뉴에서Open content from SCAP Security Guide또는Open Other Content를 열어 사용자 지정할 프로필을 선택합니다. 요구 사항에 따라 선택한 보안 프로필을 조정하려면 사용자 지정 버튼을 클릭합니다.

그러면 원래 데이터 스트림 파일을 변경하지 않고 현재 선택한 프로필을 수정할 수 있는 새 사용자 지정 창이 열립니다. 새 프로필 ID를 선택합니다.

- 논리 그룹 또는 Search (검색) 필드로 구성된 규칙과 함께 트리 구조를 사용하여 수정하는 규칙을 찾습니다.

트리 구조의 확인란을 사용하여 규칙을 포함하거나 제외하거나 해당하는 규칙의 값을 수정합니다.

- OK (확인) 버튼을 클릭하여 변경 사항을 확인합니다.

변경 사항을 영구적으로 저장하려면 다음 옵션 중 하나를 사용합니다.

-

File메뉴에서Save Customization only을 사용하여 사용자 지정 파일을 별도로 저장합니다. File메뉴에서Save All을 사용하여 한 번에 모든 보안 콘텐츠를 저장합니다.Into a directory옵션을 선택하면SCAP Workbench는 데이터 스트림 파일과 사용자 지정 파일을 지정된 위치에 모두 저장합니다. 이를 백업 솔루션으로 사용할 수 있습니다.As RPM옵션을 선택하면SCAP Workbench에 데이터 스트림 파일과 사용자 지정 파일이 포함된 RPM 패키지를 생성하도록 지시할 수 있습니다. 이 기능은 원격으로 스캔할 수 없는 시스템에 보안 콘텐츠를 배포하고 추가 처리를 위해 콘텐츠를 전달하는 데 유용합니다.

-

SCAP Workbench 는 맞춤형 프로필의 결과 기반 수정을 지원하지 않으므로 oscap 명령줄 유틸리티와 함께 내보낸 수정을 사용합니다.

7.8.3. 추가 리소스

-

scap-workbench(8)도움말 페이지 -

scap-workbench패키지에서 제공하는/usr/share/doc/scap-workbench/user_manual.html파일 - Satellite 6.x를 사용하여 사용자 정의 SCAP 정책 배포 KCS 문서

7.9. 설치 직후 보안 프로필과 호환되는 시스템 배포

OpenSCAP 제품군을 사용하여 설치 프로세스 직후에 OSPP, PCI-DSS 및 HIPAA 프로필과 같은 보안 프로필과 호환되는 RHEL 시스템을 배포할 수 있습니다. 이 배포 방법을 사용하여 나중에 해결 스크립트를 사용하여 적용할 수 없는 특정 규칙을 적용할 수 있습니다 (예: 암호 보안 강도 및 파티셔닝 규칙).

7.9.1. GUI에서 서버와 호환되지 않는 프로파일

SCAP 보안 가이드의 일부로 제공되는 특정 보안 프로필은 GUI 기본 환경에서 서버에 포함된 확장 패키지 세트와 호환되지 않습니다. 따라서 다음 프로필 중 하나와 호환되는 시스템을 설치할 때 GUI를 사용하여 서버를 선택하지 마십시오.

표 7.1. GUI에서 서버와 호환되지 않는 프로파일

| 프로파일 이름 | 프로파일 ID | 이유 | 참고 |

|---|---|---|---|

| [DRAFT] Level 2 - Server의 CIS Red Hat Enterprise Linux 9 벤치마크 |

|

패키지 | |

| [DRAFT] Level 1 - Server의 CIS Red Hat Enterprise Linux 9 벤치마크 |

|

패키지 | |

| [DRAFT] Red Hat Enterprise Linux 9의 DISA STIG |

|

패키지 | DISA STIG 와 일치하는 GUI가 있는 서버로 RHEL 시스템을 설치하려면 GUI 프로필 BZ#1648162와 함께 DISA STIG 를 사용할 수 있습니다. |

7.9.2. 그래픽 설치를 사용하여 기준으로 호환되는 RHEL 시스템 배포

특정 기준과 일치하는 RHEL 시스템을 배포하려면 다음 절차를 사용하십시오. 이 예에서는 OSDPP(General Purpose Operating System)에 보안 프로필을 사용합니다.

SCAP 보안 가이드의 일부로 제공되는 특정 보안 프로필은 GUI 기본 환경에서 서버에 포함된 확장 패키지 세트와 호환되지 않습니다. 자세한 내용은 GUI 서버와 호환되지 않는 프로필을 참조하십시오.

사전 요구 사항

-

graphical설치 프로그램으로 부팅되었습니다. OSCAP Anaconda 애드온은 대화형 텍스트 전용 설치를 지원하지 않습니다. -

Installation Summary창에 액세스했습니다.

절차

-

Installation Summary창에서Software Selection을 클릭합니다.Software Selection창이 열립니다. -

Base Environment창에서Server환경을 선택합니다. 기본 환경 하나만 선택할 수 있습니다. -

Done을 클릭하여 설정을 적용하고Installation Summary창으로 돌아갑니다. -

OSPP에는 충족해야 하는 엄격한 파티셔닝 요구 사항이 있으므로

/boot,/home, /var ,/tmp,/var/log/var/tmp,/var/log/audit에 대해 별도의 파티션을 생성하십시오. -

Security Policy를 클릭합니다.Security Policy창이 열립니다. -

시스템에서 보안 정책을 활성화하려면

Apply security policy을ON으로 전환합니다. -

프로필 창에서 General Purpose Operating Systems의

Protection Profile for General Purpose Operating Systems를 선택합니다. -

Select Profile을 클릭하여 선택을 확인합니다. -

Changes that were done or need to be done을 확인합니다. 나머지 수동 변경 사항을 완료합니다. 그래픽 설치 프로세스를 완료합니다.

참고성공적인 설치 후 그래픽 설치 프로그램은 해당 Kickstart 파일을 자동으로 생성합니다.

/root/anaconda-ks.cfg파일을 사용하여 OSPP 호환 시스템을 자동으로 설치할 수 있습니다.

검증

설치가 완료된 후 시스템의 현재 상태를 확인하려면 시스템을 재부팅하고 새 검사를 시작합니다.

# oscap xccdf eval --profile ospp --report eval_postinstall_report.html /usr/share/xml/scap/ssg/content/ssg-rhel9-ds.xml

추가 리소스

7.9.3. Kickstart를 사용하여 기준 준수 RHEL 시스템 배포

특정 기준과 일치하는 RHEL 시스템을 배포하려면 다음 절차를 사용하십시오. 이 예에서는 OSDPP(General Purpose Operating System)에 보안 프로필을 사용합니다.

사전 요구 사항

-

scap-security-guide패키지가 RHEL 9 시스템에 설치되어 있습니다.

절차

-

선택한 편집기에서

/usr/share/scap-security-guide/kickstart/ssg-rhel9-ospp-ks.cfgKickstart 파일을 엽니다. -

구성 요구 사항에 맞게 파티션 구성표를 업데이트합니다. OSPP 규정 준수의 경우

/boot/home,/var,/tmp,/var/log,/var/tmp,/var/log/audit에 대한 별도의 파티션을 유지해야 하며 파티션 크기만 변경할 수 있습니다. - Kickstart를 사용하여 자동 설치를 수행하는 방법에 설명된 대로 Kickstart 설치를 시작합니다.

Kickstart 파일의 암호는 OSPP 요구 사항에 대해 확인되지 않습니다.

검증

설치가 완료된 후 시스템의 현재 상태를 확인하려면 시스템을 재부팅하고 새 검사를 시작합니다.

# oscap xccdf eval --profile ospp --report eval_postinstall_report.html /usr/share/xml/scap/ssg/content/ssg-rhel9-ds.xml

추가 리소스

7.10. 컨테이너 및 컨테이너 이미지에서 취약점 스캔

컨테이너 또는 컨테이너 이미지에서 보안 취약점을 찾으려면 다음 절차를 사용하십시오.

사전 요구 사항

-

openscap-utils및bzip2패키지가 설치됩니다.

절차

시스템에 대한 최신 RHSA OVAL 정의를 다운로드합니다.

# wget -O - https://www.redhat.com/security/data/oval/v2/RHEL9/rhel-9.oval.xml.bz2 | bzip2 --decompress > rhel-9.oval.xml컨테이너 또는 컨테이너 이미지의 ID를 가져옵니다. 예를 들면 다음과 같습니다.

# podman images REPOSITORY TAG IMAGE ID CREATED SIZE registry.access.redhat.com/ubi9/ubi latest 096cae65a207 7 weeks ago 239 MB컨테이너 또는 컨테이너 이미지에서 취약점을 검사하고 결과를 vulnerability.html 파일에 저장합니다.

# oscap-podman 096cae65a207 oval eval --report vulnerability.html rhel-9.oval.xmloscap-podman명령에는 루트 권한이 필요하며 컨테이너 ID는 첫 번째 인수입니다.

검증

선택한 브라우저의 결과를 확인합니다. 예를 들면 다음과 같습니다.

$ firefox vulnerability.html &

추가 리소스

-

자세한 내용은

oscap-podman(8)및oscap(8)도움말 페이지를 참조하십시오.

7.11. 특정 기준에서 컨테이너 또는 컨테이너 이미지의 보안 준수 평가

다음 단계에 따라 OSPP(운영 체제 보호 프로필), PCI-DSS(Payment Card Industry Data Security Standard) 및 HIPAA(Health Insurance Portability and Accountability Act)와 같은 특정 보안 기준이 있는 컨테이너 또는 컨테이너 이미지의 준수를 평가합니다.

사전 요구 사항

-

openscap-utils및scap-security-guide패키지가 설치되어 있습니다.

절차

컨테이너 또는 컨테이너 이미지의 ID를 가져옵니다. 예를 들면 다음과 같습니다.

# podman images REPOSITORY TAG IMAGE ID CREATED SIZE registry.access.redhat.com/ubi9/ubi latest 096cae65a207 7 weeks ago 239 MBHIPAA 프로필을 사용하여 컨테이너 이미지의 규정 준수를 평가하고 검사 결과를 report.html HTML 파일에 저장합니다.

# oscap-podman 096cae65a207 xccdf eval --report report.html --profile hipaa /usr/share/xml/scap/ssg/content/ssg-rhel9-ds.xml보안 준수 여부를 OSPP 또는 PCI-DSS 기준으로 평가하면 096cae65a207 을 컨테이너 이미지의 ID로, hipaa 값을 ospp 또는 pci-dss 로 바꿉니다.

oscap-podman명령에는 root 권한이 필요합니다.

검증

선택한 브라우저의 결과를 확인합니다. 예를 들면 다음과 같습니다.

$ firefox report.html &

적용되지 않음으로 표시된 규칙은 컨테이너화된 시스템에 적용되지 않는 규칙입니다. 이러한 규칙은 베어 메탈 및 가상화 시스템에만 적용됩니다.

추가 리소스

-

oscap-podman(8)및scap-security-guide(8)도움말 페이지. -

/usr/share/doc/scap-security-guide/디렉터리.

7.12. RHEL 9에서 지원되는 SCAP 보안 가이드 프로필

RHEL의 특정 마이너 릴리스에서 제공된 SCAP 콘텐츠만 사용합니다. 강화에 참여하는 구성 요소가 새로운 기능으로 업데이트되는 경우가 있기 때문입니다. 이러한 업데이트를 반영하기 위해 SCAP 콘텐츠 변경이 필요하지만 이전 버전과 항상 호환되지는 않습니다.

다음 표에서는 프로필이 일치하는 정책 버전과 함께 RHEL 9에 제공된 프로필을 확인할 수 있습니다.

표 7.2. RHEL 9.2에서 지원되는 SCAP 보안 가이드 프로필

| 프로파일 이름 | 프로파일 ID | 정책 버전 |

|---|---|---|

| French National Agency for the Security of Information Systems (ANSSI) BP-028 Enhanced Level |

|

RHEL 9.2.0에서 RHEL 9.2.2:1.2 |

| French National Agency for the Security of Information Systems (ANSSI) BP-028 High Level |

|

RHEL 9.2.0에서 RHEL 9.2.2:1.2 |

| French National Agency for the Security of Information Systems (ANSSI) BP-028 Intermediary Level |

|

RHEL 9.2.0에서 RHEL 9.2.2:1.2 |

| French National Agency for the Security of Information Systems (ANSSI) BP-028 Minimal Level |

|

RHEL 9.2.0에서 RHEL 9.2.2:1.2 |

| CIS Red Hat Enterprise Linux 9 Benchmark for Level 2 - Server |

| 1.0.0 |

| CIS Red Hat Enterprise Linux 9 Benchmark for Level 1 - Server |

| 1.0.0 |

| CIS Red Hat Enterprise Linux 9 Benchmark for Level 1 - Workstation |

| 1.0.0 |

| CIS Red Hat Enterprise Linux 9 Benchmark for Level 2 - Workstation |

| 1.0.0 |

| [DRAFT] 비료 정보 시스템 및 조직에서 분류되지 않은 정보 (NIST 800-171) |

| r2 |

| Australian Cyber Security Centre (ACSC) Essential Eight |

| 버전이 지정되지 않음 |

| HIPAA(Health Insurance Portability and Accountability Act) |

| 버전이 지정되지 않음 |

| Australian Cyber Security Centre (ACSC) ISM Official |

| 버전이 지정되지 않음 |

| Protection Profile for General Purpose Operating Systems |

| 4.2.1 |

| PCI-DSS v3.2.1 Control Baseline for Red Hat Enterprise Linux 9 |

| 3.2.1 |

| [DRAFT] Red Hat Enterprise Linux 9의 DISA STIG |

| 초안[a] |

| [DRAFT] Red Hat Enterprise Linux 9용 GUI를 사용하는 DISA STIG |

| DRAFT[a] |

| CCN Red Hat Enterprise Linux 9 - Basic |

| RHEL 9.2.0 이상:2022-10 |

| CCN Red Hat Enterprise Linux 9 - Intermediate |

| RHEL 9.2.0 이상:2022-10 |

| CCN Red Hat Enterprise Linux 9 - 고급 |

| RHEL 9.2.0 이상:2022-10 |

[a]

DISA는 아직 RHEL 9에 대한 공식 벤치마크를 발표하지 않았습니다.

| ||

표 7.3. RHEL 9.1에서 지원되는 SCAP Security Guide 프로필

| 프로파일 이름 | 프로파일 ID | 정책 버전 |

|---|---|---|

| French National Agency for the Security of Information Systems (ANSSI) BP-028 Enhanced Level |

| 1.2 |

| French National Agency for the Security of Information Systems (ANSSI) BP-028 High Level |

| 1.2 |

| French National Agency for the Security of Information Systems (ANSSI) BP-028 Intermediary Level |

| 1.2 |

| French National Agency for the Security of Information Systems (ANSSI) BP-028 Minimal Level |

| 1.2 |

| CIS Red Hat Enterprise Linux 9 Benchmark for Level 2 - Server |

|

RHEL 9.1.0 및 RHEL 9.1.1:DRAFT[a] |

| CIS Red Hat Enterprise Linux 9 Benchmark for Level 1 - Server |

|

RHEL 9.1.0 및 RHEL 9.1.1:DRAFT[a] |

| CIS Red Hat Enterprise Linux 9 Benchmark for Level 1 - Workstation |

|

RHEL 9.1.0 및 RHEL 9.1.1:DRAFT[a] |

| CIS Red Hat Enterprise Linux 9 Benchmark for Level 2 - Workstation |

|

RHEL 9.1.0 및 RHEL 9.1.1:DRAFT[a] |

| [DRAFT] 비료 정보 시스템 및 조직에서 분류되지 않은 정보 (NIST 800-171) |

| r2 |

| Australian Cyber Security Centre (ACSC) Essential Eight |

| 버전이 지정되지 않음 |

| HIPAA(Health Insurance Portability and Accountability Act) |

| 버전이 지정되지 않음 |

| Australian Cyber Security Centre (ACSC) ISM Official |

| 버전이 지정되지 않음 |

| Protection Profile for General Purpose Operating Systems |

| 4.2.1 |

| PCI-DSS v3.2.1 Control Baseline for Red Hat Enterprise Linux 9 |

| 3.2.1 |

| [DRAFT] Red Hat Enterprise Linux 9의 DISA STIG |

| DRAFT[a] |

| [DRAFT] Red Hat Enterprise Linux 9용 GUI를 사용하는 DISA STIG |

| DRAFT[a] |

[a]

CIS는 아직 RHEL 9에 대한 공식 벤치마크를 게시하지 않았습니다.

| ||

표 7.4. RHEL 9.0에서 지원되는 SCAP Security Guide 프로파일

| 프로파일 이름 | 프로파일 ID | 정책 버전 |

|---|---|---|

| French National Agency for the Security of Information Systems (ANSSI) BP-028 Enhanced Level |

|

RHEL 9.0.0에서 RHEL 9.0.10:1.2 |

| French National Agency for the Security of Information Systems (ANSSI) BP-028 High Level |

|

RHEL 9.0.0에서 RHEL 9.0.10:1.2 |

| French National Agency for the Security of Information Systems (ANSSI) BP-028 Intermediary Level |

|

RHEL 9.0.0에서 RHEL 9.0.10:1.2 |

| French National Agency for the Security of Information Systems (ANSSI) BP-028 Minimal Level |

|

RHEL 9.0.0에서 RHEL 9.0.10:1.2 |

| CIS Red Hat Enterprise Linux 9 Benchmark for Level 2 - Server |

|

RHEL 9.0.0에서 RHEL 9.0.6:DRAFT[a] |

| CIS Red Hat Enterprise Linux 9 Benchmark for Level 1 - Server |

|

RHEL 9.0.0에서 RHEL 9.0.6:DRAFT[a] |

| CIS Red Hat Enterprise Linux 9 Benchmark for Level 1 - Workstation |

|

RHEL 9.0.0에서 RHEL 9.0.6:DRAFT[a] |

| CIS Red Hat Enterprise Linux 9 Benchmark for Level 2 - Workstation |

|

RHEL 9.0.0에서 RHEL 9.0.6:DRAFT[a] |

| [DRAFT] 비료 정보 시스템 및 조직에서 분류되지 않은 정보 (NIST 800-171) |

| r2 |

| Australian Cyber Security Centre (ACSC) Essential Eight |

| 버전이 지정되지 않음 |

| HIPAA(Health Insurance Portability and Accountability Act) |

| 버전이 지정되지 않음 |

| Australian Cyber Security Centre (ACSC) ISM Official |

| 버전이 지정되지 않음 |

| Protection Profile for General Purpose Operating Systems |

|

RHEL 9.0.0에서 RHEL 9.0.2:DRAFT |

| PCI-DSS v3.2.1 Control Baseline for Red Hat Enterprise Linux 9 |

| 3.2.1 |

| [DRAFT] Red Hat Enterprise Linux 9의 DISA STIG |

| DRAFT[a] |

| [DRAFT] Red Hat Enterprise Linux 9용 GUI를 사용하는 DISA STIG |

| DRAFT[a] |

| CCN Red Hat Enterprise Linux 9 - Basic |

| RHEL 9.0.11 이상:2022-10 |

| CCN Red Hat Enterprise Linux 9 - Intermediate |

| RHEL 9.0.11 이상:2022-10 |

| CCN Red Hat Enterprise Linux 9 - 고급 |

| RHEL 9.0.11 이상:2022-10 |

7.13. 추가 리소스

- RHEL에서 지원되는 SCAP 보안 가이드 버전

-

OpenSCAP 프로젝트 페이지는

oscap유틸리티 및 SCAP와 관련된 기타 구성 요소 및 프로젝트에 대한 자세한 정보를 제공합니다. -

SCAP Workbench 프로젝트 페이지는

scap-workbench애플리케이션에 대한 자세한 정보를 제공합니다. - SCAP Security Guide (SSG) 프로젝트 페이지에서 는 Red Hat Enterprise Linux에 최신 보안 컨텐츠를 제공합니다.

- 보안 컴플라이언스 및 취약점 스캔에 OpenSCAP 사용 - RHEL의 규정 준수 및 취약점 스캔을 위해 SCAP(Security Content Automation Protocol) 표준을 기반으로 하는 툴 실행에 대한 실습 랩입니다.

- Red Hat 보안 데모: 사용자 지정 보안 정책 콘텐츠 Automate Security Compliance - 업계 표준 보안 정책 및 사용자 지정 보안 정책을 준수하기 위해 RHEL에 포함된 툴을 사용하여 보안 준수 자동화에 대한 초기 경험을 얻을 수 있습니다. 팀을 위해 교육을 받거나 이러한 실습에 액세스하려면 Red Hat 계정 팀에 자세한 내용을 문의하십시오.

- Red Hat 보안 데모: RHEL Security Technologies - OpenSCAP을 포함하여 RHEL에서 사용 가능한 주요 보안 기술을 사용하여 RHEL 시스템의 모든 수준에서 보안을 구현하는 방법을 배울 수 있는 실습 랩입니다. 팀을 위해 교육을 받거나 이러한 실습에 액세스하려면 Red Hat 계정 팀에 자세한 내용을 문의하십시오.

- NSS (National research of Standards and Technology) SCAP 페이지에 는 SCAP 발행물, 사양 및 SCAP 검증 프로그램을 포함한 광범위한 SCAP 관련 자료 컬렉션이 있습니다.

- NVD(National Vulnerability Database) 는 가장 큰 SCAP 콘텐츠 저장소와 기타 SCAP 표준 기반 취약점 관리 데이터를 보유하고 있습니다.

- Red Hat OVAL 콘텐츠 리포지토리에 는 RHEL 시스템의 취약점에 대한 OVAL 정의가 포함되어 있습니다. 권장되는 취약점 콘텐츠 소스입니다.

- MITRE CVE - MITRE 기업에서 제공하는 알려진 보안 취약점의 데이터베이스입니다. RHEL의 경우 Red Hat에서 제공하는 OVAL CVE 콘텐츠를 사용하는 것이 좋습니다.

- MITRE OVAL - 이는 MITRE 기업이 제공하는 OVAL 관련 프로젝트입니다. 다른 OVAL 관련 정보 중 하나로 이러한 페이지에는 OVAL 언어 및 수천 개의 OVAL 정의가 포함된 OVAL 콘텐츠 리포지토리가 포함되어 있습니다. RHEL 스캔에는 Red Hat에서 제공하는 OVAL CVE 콘텐츠를 사용하는 것이 좋습니다.

- Red Hat Satellite에서 보안 규정 준수 관리 - 이 가이드 세트는 OpenSCAP을 사용하여 여러 시스템에서 시스템 보안을 유지하는 방법을 설명합니다.

8장. Keylime을 사용하여 시스템 무결성 보장

Keylime을 사용하면 원격 시스템의 무결성을 지속적으로 모니터링하고 부팅 시 시스템 상태를 확인할 수 있습니다. 암호화된 파일을 모니터링된 시스템으로 보내고 모니터링 중인 시스템이 무결성 테스트에 실패할 때마다 트리거된 자동 작업을 지정할 수도 있습니다.

8.1. Keylime 작동 방식

Keylime 에이전트를 배포하여 다음 작업 중 하나 이상을 수행할 수 있습니다.

- 런타임 무결성 모니터링

- Keylime 런타임 무결성 모니터링은 에이전트가 배포된 시스템을 지속적으로 모니터링하고 허용 목록에 포함된 파일의 무결성을 측정하고 excludelist에 포함되지 않습니다.

- 측정된 부팅

- Keylime 측정된 부팅은 부팅 시 시스템 상태를 확인합니다.

Keylime의 신뢰 개념은 TPM(Trusted Platform Module) 기술을 기반으로 합니다. TPM은 통합된 암호화 키가 있는 하드웨어, 펌웨어 또는 가상 구성 요소입니다. TPM 따옴표를 폴링하고 오브젝트 해시를 비교함으로써 Keylime은 원격 시스템의 초기 및 런타임 모니터링을 제공합니다.

가상 머신에서 실행 중이거나 가상 TPM을 사용하는 것은 기본 호스트의 무결성에 따라 달라집니다. 가상 환경의 Keylime 측정에 의존하기 전에 호스트 환경을 신뢰해야 합니다.

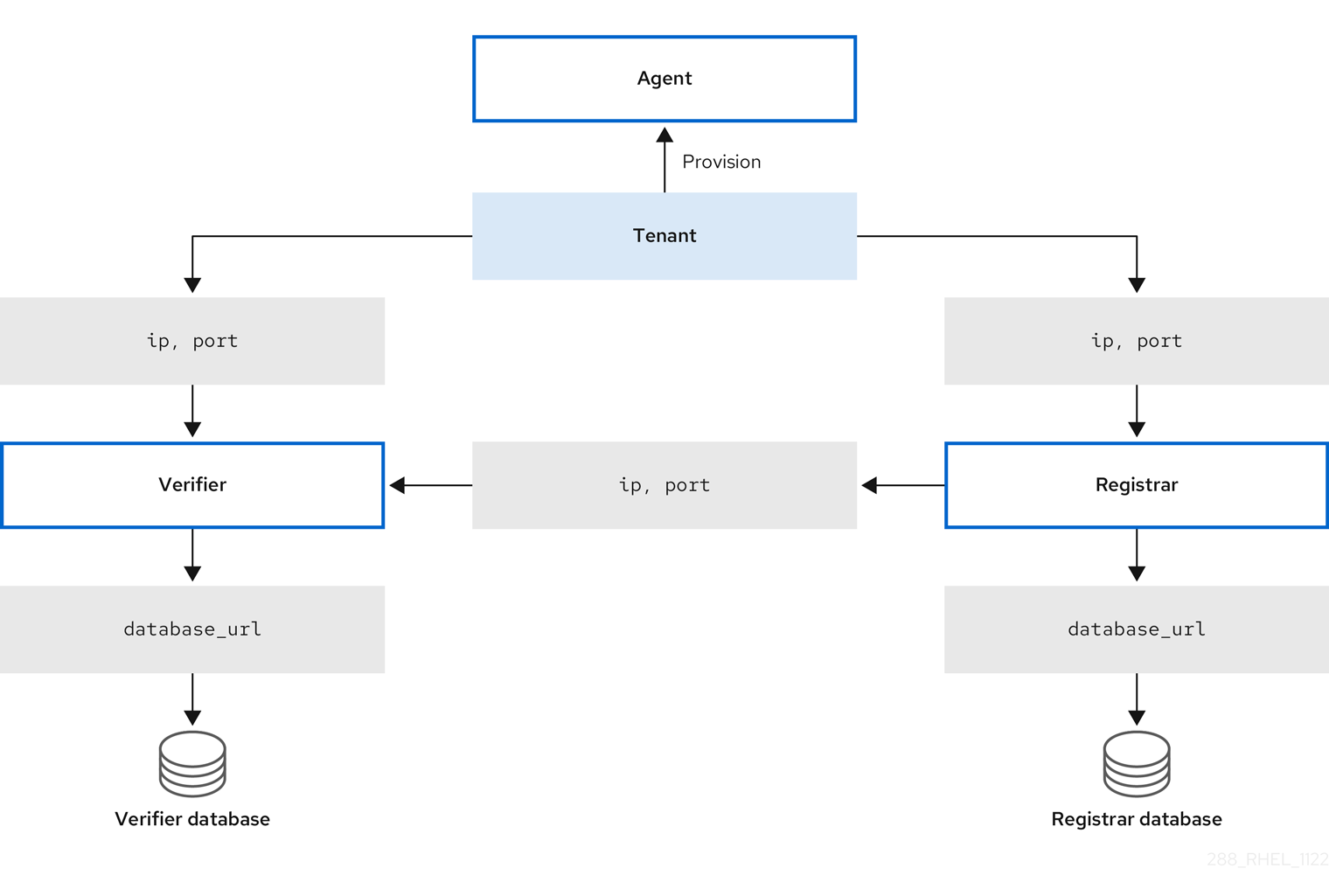

Keylime는 세 가지 주요 구성 요소로 구성됩니다.

- Verifier

- 처음에는 에이전트를 실행하는 시스템의 무결성을 지속적으로 확인합니다.

- Registrar

- 모든 에이전트의 데이터베이스를 포함하며 TPM 공급 업체의 공개 키를 호스팅합니다.

- agent

- 검증기에서 측정한 원격 시스템에 배포됩니다.

또한 Keylime은 대상 시스템에서 에이전트를 프로비저닝하는 것을 포함하여 많은 기능에 keylime_tenant 유틸리티를 사용합니다.

그림 8.1. 구성을 통한 Keylime 구성 요소 간 연결

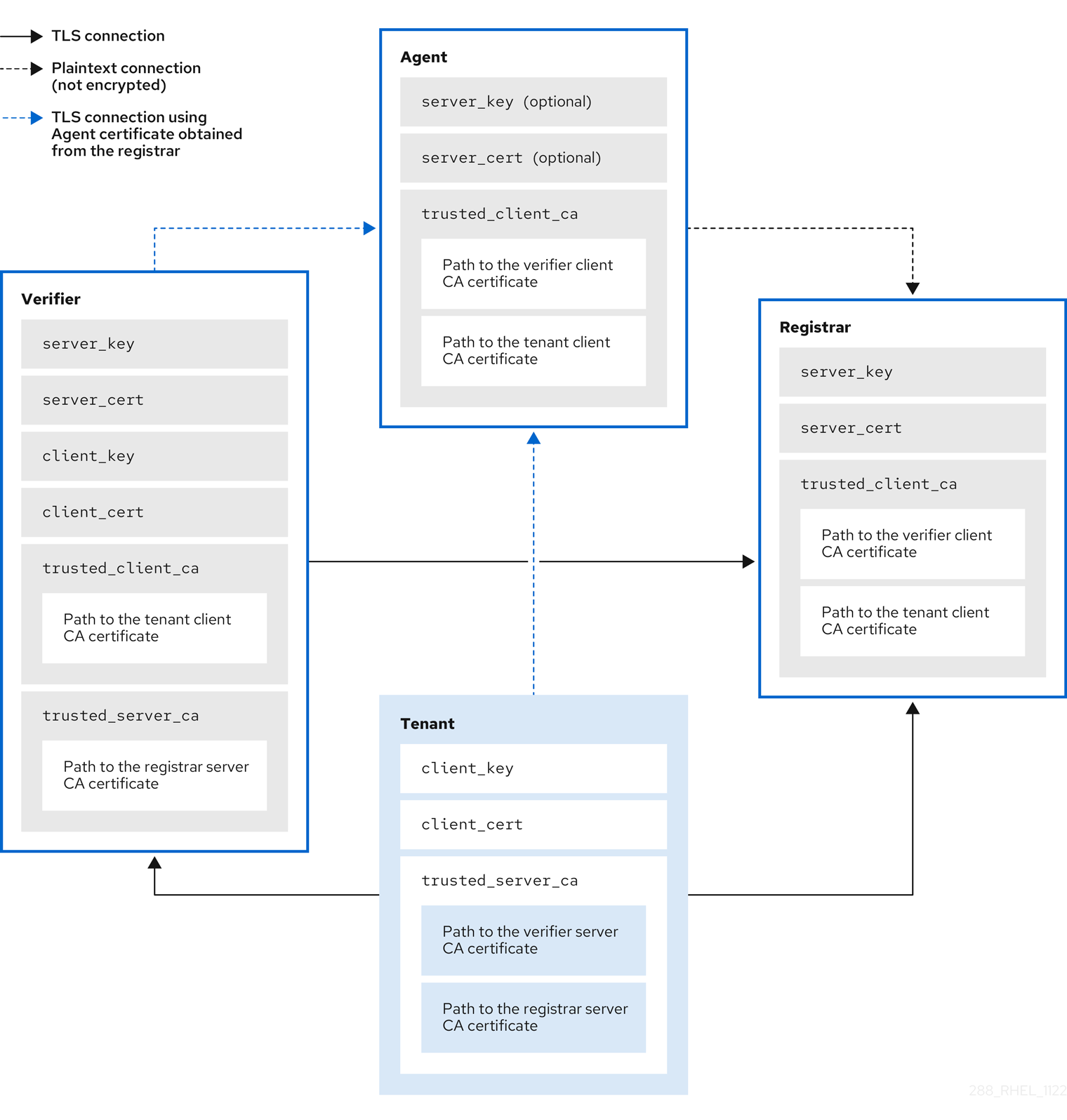

Keylime은 구성 요소와 테넌트 간에 교환된 키와 인증서를 사용하여 신뢰 체인에서 모니터링되는 시스템의 무결성을 보장합니다. 이 체인의 안전한 기반은 신뢰할 수 있는 CA(인증 기관)를 사용합니다.

에이전트가 키 및 인증서를 수신하지 않으면 CA에서 부여하지 않고 키와 자체 서명 인증서를 생성합니다.

그림 8.2. Keylime 구성 요소 인증서와 키 간 연결

8.2. Keylime 검증 구성

검증자는 Keylime에서 가장 중요한 구성 요소입니다. 시스템 무결성의 초기 및 주기적 검사를 수행하고 에이전트를 통해 암호화 키 부트스트랩을 지원합니다. 검증자는 제어 인터페이스에 TLS(mutual Transport Layer Security)를 사용합니다.

신뢰 체인을 유지하려면 검증기를 실행하는 시스템을 안전하고 제어할 수 있도록 유지합니다.

검증자는 요구 사항에 따라 별도의 시스템 또는 Keylime 등록 기관과 동일한 시스템에 설치할 수 있습니다. 별도의 시스템에서 검증기 및 등록 기관을 실행하면 성능이 향상됩니다.

구성 파일을 드롭인 디렉터리 내에서 유지하려면 두 자리 숫자 접두사(예: /etc/keylime/verifier.conf.d/00-verifier-ip.conf )와 함께 파일 이름을 사용합니다. 구성 처리는 드롭인 디렉터리 내의 파일을 사전순으로 읽고 각 옵션을 읽은 마지막 값으로 설정합니다.

사전 요구 사항

-

Keylime 구성 요소를 설치하려는 시스템 또는 시스템에 대한

루트권한 및 네트워크 연결이 있습니다. - 인증 기관의 유효한 키와 인증서가 있습니다.

선택 사항: Keylime은 등록 기관 및 검증자로부터 데이터를 저장하는 두 개의 데이터베이스에 액세스할 수 있습니다. 다음 데이터베이스 관리 시스템을 사용할 수 있습니다.

- SQLite(기본값)

- PostgreSQL

- MySQL

- MariaDB

절차

Keylime 검증기를 설치합니다.

# dnf install keylime-verifier확인자 구성에서 등록 기관 및 검증기의 IP 주소 및 포트를 정의합니다.

/etc/keylime/verifier디렉터리에 새 .conf 파일을 만듭니다(예:.conf.d//etc/keylime/verifier.conf.d/00-verifier-ip.conf).[verifier] ip = <verifier_IP_address>

-

&

lt;verifier_IP_address>를 검증자의 IP 주소로 바꿉니다. 또는ip = *또는ip = 0.0.0.0을 사용하여 확인자를 사용 가능한 모든 IP 주소에 바인딩합니다. -

선택적으로 port

= < verifier_port> 옵션을 사용하여 기본 값를 변경할 수도 있습니다.8881에서 검증자의 포트

-

&

/etc/keylime/verifier디렉터리에 새 .conf 파일을 만듭니다(예:.conf.d//etc/keylime/verifier.conf.d/00-registrar-ip.conf).[verifier] registrar_ip = <registrar_IP_address>-

&

lt;registrar_IP_address>를 등록 기관의 IP 주소로 바꿉니다. -

등록 기관이 기본값

8891과 다른 포트를 사용하는 경우registrar_port = < registrar_port> 설정을추가합니다.

-

&

선택 사항: 에이전트 목록에 대해 검증자 데이터베이스를 구성합니다. 기본 구성은 검증자의

/var/lib/keylime/cv_data.sqlite/디렉터리의 SQLite 데이터베이스를 사용합니다. /etc/keylime/verifier.conf.d/ 디렉터리에 새 .conf 파일을 생성하여 다른 데이터베이스를 정의할 수 있습니다(예:/etc/keylime/verifier.conf.d/00-db-url.conf[verifier] database_url = <protocol>://<name>:<password>@<ip_address_or_hostname>/<properties><

protocol>://<name>:<password>@<ip_address_or_hostname>/<properties>를 데이터베이스의 URL로 바꿉니다(예:postgresql://verifier:UQ?nRNY9g7GZzN7@198.51.100.1/verifierdb).사용하는 인증 정보에 데이터베이스 구조를 생성하기 위한 Keylime에 대한 권한이 있는지 확인합니다.

검증에 인증서와 키를 추가합니다. Keylime에서 해당 키를 생성하거나 기존 키 및 인증서를 사용하도록 할 수 있습니다.

-

기본

tls_dir = generate옵션을 사용하면 Keylime에서 검증자, 등록 기관 및 테넌트에 대한 새 인증서를/var/lib/keylime/cv_ca/디렉터리에 생성합니다. 구성에서 기존 키와 인증서를 로드하려면 확인자 구성에서 해당 위치를 정의합니다.

참고인증서는 Keylime 서비스가 실행되는

keylime사용자가 액세스할 수 있어야 합니다./etc/keylime/verifier

.conf.d/ 디렉터리에 새 .conf 파일을 만듭니다(예:/etc/keylime/verifier.conf.d/00-keys-and-certs.conf[verifier] tls_dir = /var/lib/keylime/cv_ca server_key = </path/to/server_key> server_key_password = <passphrase1> server_cert = </path/to/server_cert> trusted_client_ca = ['</path/to/ca/cert1>', '</path/to/ca/cert2>'] client_key = </path/to/client_key> client_key_password = <passphrase2> client_cert = </path/to/client_cert> trusted_server_ca = ['</path/to/ca/cert3>', '</path/to/ca/cert4>']

참고절대 경로를 사용하여 키 및 인증서 위치를 정의합니다. 또는

tls_dir옵션에 정의된 디렉터리에서 상대 경로가 확인됩니다.

-

기본

방화벽에서 포트를 엽니다.

# firewall-cmd --add-port 8881/tcp # firewall-cmd --runtime-to-permanent

다른 포트를 사용하는 경우

8881을.conf파일에 정의된 포트 번호로 바꿉니다.검증 서비스를 시작합니다.

# systemctl enable --now keylime_verifier참고기본 구성에서 확인자가 다른 Keylime 구성 요소에 대한 CA 및 인증서를 생성하므로

keylime_registrar서비스를 시작하기 전에keylime_verifier를 시작합니다. 사용자 정의 인증서를 사용할 때는 이 순서가 필요하지 않습니다.

검증

keylime_verifier서비스가 활성화되어 실행 중인지 확인합니다.# systemctl status keylime_verifier ● keylime_verifier.service - The Keylime verifier Loaded: loaded (/usr/lib/systemd/system/keylime_verifier.service; disabled; vendor preset: disabled) Active: active (running) since Wed 2022-11-09 10:10:08 EST; 1min 45s ago

다음 단계

8.3. Keylime 등록 기관 구성

등록 기관은 모든 에이전트의 데이터베이스가 포함된 Keylime 구성 요소이며 TPM 공급 업체의 공개 키를 호스팅합니다. 등록 기관의 HTTPS 서비스에서 신뢰할 수 있는 플랫폼 모듈(TPM) 공개 키를 허용하면 따옴표를 확인하기 위해 이러한 공개 키를 가져오는 인터페이스가 제공됩니다.

신뢰 체인을 유지하려면 등록 기관을 실행하는 시스템을 안전하게 유지하고 제어하에 두십시오.

요구 사항에 따라 별도의 시스템 또는 Keylime verifier와 동일한 시스템에 등록 기관을 설치할 수 있습니다. 별도의 시스템에서 검증기 및 등록 기관을 실행하면 성능이 향상됩니다.

구성 파일을 드롭인 디렉터리 내에서 유지하려면 두 자리 번호 접두사(예: /etc/keylime/registrar.conf.d/00-registrar-ip.conf )와 함께 파일 이름을 사용합니다. 구성 처리는 드롭인 디렉터리 내의 파일을 사전순으로 읽고 각 옵션을 읽은 마지막 값으로 설정합니다.

사전 요구 사항

- Keylime 검증기가 설치되어 실행 중인 시스템에 대한 네트워크 액세스 권한이 있습니다. 자세한 내용은 8.2절. “Keylime 검증 구성”의 내용을 참조하십시오.

-

Keylime 구성 요소를 설치하려는 시스템 또는 시스템에 대한

루트권한 및 네트워크 연결이 있습니다. 두 개의 데이터베이스에 액세스할 수 있습니다. 여기서 Keylime은 등록 기관 및 검증자에서 데이터를 저장합니다.

다음 데이터베이스 관리 시스템을 사용할 수 있습니다.

- SQLite(기본값)

- PostgreSQL

- MySQL

- MariaDB

- 인증 기관의 유효한 키와 인증서가 있습니다.

절차

Keylime 등록 기관을 설치합니다.

# dnf install keylime-registrar등록 기관의 IP 주소 및 포트를 정의합니다.

/etc/keylime/registrar디렉터리에 새 .conf 파일을 만듭니다(예:.conf.d//etc/keylime/registrar.conf.d/00-registrar-ip.conf).[registrar] ip = <registrar_IP_address>-

&

lt;registrar_IP_address>를 등록 기관의 IP 주소로 바꿉니다. 또는ip = *또는ip = 0.0.0.0을 사용하여 사용 가능한 모든 IP 주소에 등록 기관을 바인딩합니다. -

선택적으로

port =옵션을 사용하여 Keylime 에이전트가 연결하는 포트를 변경합니다. 기본값은8890입니다. -

필요한 경우

tls_port =옵션을 사용하여 Keylime verifier 및 테넌트가 연결하는 TLS 포트를 변경합니다. 기본값은8891입니다.

-

&

선택 사항: 에이전트 목록에 대한 등록 기관의 데이터베이스를 구성합니다. 기본 구성에서는 등록 기관의

/var/lib/keylime/reg_data.sqlite디렉터리의 SQLite 데이터베이스를 사용합니다./etc/keylime/registrar디렉터리에 새 .conf 파일을 생성할 수 있습니다(예:.conf.d//etc/keylime/registrar.conf.d/00-db-url.conf).[registrar] database_url = <protocol>://<name>:<password>@<ip_address_or_hostname>/<properties><

protocol>://<name>:<password>@<ip_address_or_hostname>/<properties>를 데이터베이스의 URL로 바꿉니다(예:postgresql://registrar:EKYYX-bqY2?#raXm@198.51.100.1/registrardb).사용하는 인증 정보에 데이터베이스 구조를 생성하기 위한 Keylime에 대한 권한이 있는지 확인합니다.

등록 기관에 인증서 및 키를 추가합니다.

-

기본 구성을 사용하여 키와 인증서를

/var/lib/keylime/reg_ca/디렉터리에 로드할 수 있습니다. 또는 구성에서 키와 인증서의 위치를 정의할 수 있습니다. /etc/keylime/registrar

.conf.d/ 디렉터리에 새 .conf 파일을 만듭니다(예:/etc/keylime/registrar.conf.d/00-keys-and-certs.conf중요사용자 정의 CA 인증서와 함께

tls_dir = default설정을 사용하지 마십시오. 대신 인증서 위치 경로를 지정합니다. 자세한 내용은 RHELPLAN-157337 을 참조하십시오.[registrar] tls_dir = /var/lib/keylime/reg_ca server_key = </path/to/server_key> server_key_password = <passphrase1> server_cert = </path/to/server_cert> trusted_client_ca = ['</path/to/ca/cert1>', '</path/to/ca/cert2>']

참고절대 경로를 사용하여 키 및 인증서 위치를 정의합니다. 또는

tls_dir옵션에 디렉터리를 정의하고 해당 디렉터리에 상대적인 경로를 사용할 수 있습니다.

-

기본 구성을 사용하여 키와 인증서를

방화벽에서 포트를 엽니다.

# firewall-cmd --add-port 8890/tcp --add-port 8891/tcp # firewall-cmd --runtime-to-permanent

다른 포트를 사용하는 경우

8890또는8891을.conf파일에 정의된 포트 번호로 바꿉니다.keylime_registrar서비스를 시작합니다.# systemctl enable --now keylime_registrar참고기본 구성에서 확인자가 다른 Keylime 구성 요소에 대한 CA 및 인증서를 생성하므로

keylime_registrar서비스를 시작하기 전에keylime_verifier를 시작합니다. 사용자 정의 인증서를 사용할 때는 이 순서가 필요하지 않습니다.

검증

keylime_registrar서비스가 활성 상태이고 실행 중인지 확인합니다.# systemctl status keylime_registrar ● keylime_registrar.service - The Keylime registrar service Loaded: loaded (/usr/lib/systemd/system/keylime_registrar.service; disabled; vendor preset: disabled) Active: active (running) since Wed 2022-11-09 10:10:17 EST; 1min 42s ago ...

다음 단계

8.4. Keylime 테넌트 구성

Keylime은 대상 시스템에서 에이전트 프로비저닝을 포함하여 많은 기능에 keylime_tenant 유틸리티를 사용합니다. 요구 사항에 따라 다른 Keylime 구성 요소를 실행하는 시스템을 포함하여 모든 시스템에 keylime_tenant 를 설치할 수 있습니다.

사전 요구 사항

-

Keylime 구성 요소를 설치하려는 시스템 또는 시스템에 대한

루트권한 및 네트워크 연결이 있습니다. 다른 Keylime 구성 요소가 구성된 시스템에 대한 네트워크 액세스 권한이 있습니다.

- Verifier

- 자세한 내용은 8.2절. “Keylime 검증 구성”의 내용을 참조하십시오.

- Registrar

- 자세한 내용은 8.3절. “Keylime 등록 기관 구성”의 내용을 참조하십시오.

절차

Keylime 테넌트를 설치합니다.

# dnf install keylime-tenant/etc/keylime/tenant.conf.d/00-verifier-ip.conf파일을 편집하여 테넌트의 Keylime 검증기를 정의합니다.[tenant] verifier_ip = <verifier_ip>-

&

lt;verifier_ip>를 검증자 시스템의 IP 주소로 바꿉니다. 또는ip = *또는ip = 0.0.0.0을 사용하여 테넌트를 사용 가능한 모든 IP 주소에 바인딩합니다. -

검증자가 기본값

8881과 다른 포트를 사용하는 경우verifier_port = < verifier_port> 설정을추가합니다.

-

&

/etc/keylime/tenant.conf.d/00-registrar-ip.conf파일을 편집하여 Keylime 등록 기관에 대한 테넌트의 연결을 정의합니다.[tenant] registrar_ip = <registrar_ip> registrar_port = <registrar_port>

-

&

lt;registrar_ip>를 등록 기관 시스템의 IP 주소로 바꿉니다. -

등록 기관이 기본값

8891과 다른 포트를 사용하는 경우registrar_port = < registrar_port> 설정을추가합니다.

-

&

테넌트에 인증서 및 키를 추가합니다.

-

기본 구성을 사용하고 키와 인증서를

/var/lib/keylime/cv_ca디렉터리에 로드할 수 있습니다. 또는 구성에서 키와 인증서의 위치를 정의할 수 있습니다.

/etc/keylime/tenant디렉터리에 새 .conf 파일을 만듭니다(예:.conf.d//etc/keylime/tenant.conf.conf.d/00-keys-and-certs.conf).[tenant] tls_dir = /var/lib/keylime/cv_ca client_key = tenant-key.pem client_key_password = <passphrase1> client_cert = tenant-cert.pem trusted_server_ca = ['</path/to/ca/cert>']

trusted_server_ca매개변수는 검증자 및 등록 기관 서버 CA 인증서에 대한 경로를 허용합니다. 예를 들어 검증자 및 등록 기관이 다른 CA를 사용하는 경우 쉼표로 구분된 여러 경로를 제공할 수 있습니다.참고절대 경로를 사용하여 키 및 인증서 위치를 정의합니다. 또는

tls_dir옵션에 디렉터리를 정의하고 해당 디렉터리에 상대적인 경로를 사용할 수 있습니다.

-

기본 구성을 사용하고 키와 인증서를

-

선택 사항: 신뢰할 수 있는 플랫폼 모듈(TPM) 승인 키(EK)가

/var/lib/keylime/tpm_cert_store디렉터리의 인증서를 사용하여 확인할 수 없는 경우 해당 디렉터리에 인증서를 추가합니다. 이는 에뮬레이션된 TPM이 있는 가상 머신을 사용할 때 특히 발생할 수 있습니다.

검증

검증의 상태를 확인합니다.