Red Hat Training

A Red Hat training course is available for RHEL 8

기본 시스템 설정 구성

시스템의 필수 기능을 설정하고 시스템 환경을 사용자 정의

초록

보다 포괄적 수용을 위한 오픈 소스 용어 교체

Red Hat은 코드, 문서 및 웹 속성에서 문제가 있는 언어를 교체하기 위해 최선을 다하고 있습니다. 먼저 마스터(master), 슬레이브(slave), 블랙리스트(blacklist), 화이트리스트(whitelist) 등 네 가지 용어를 교체하고 있습니다. 이러한 변경 작업은 작업 범위가 크므로 향후 여러 릴리스에 걸쳐 점차 구현할 예정입니다. 자세한 내용은 CTO Chris Wright의 메시지를 참조하십시오.

Red Hat 문서에 관한 피드백 제공

문서에 대한 피드백에 감사드립니다. 어떻게 개선할 수 있는지 알려주십시오.

Jira를 통해 피드백 제출 (등록 필요)

- Jira 웹 사이트에 로그인합니다.

- 상단 탐색 모음에서 생성 을 클릭합니다.

- Summary (요약) 필드에 설명 제목을 입력합니다.

- Description (설명) 필드에 개선을 위한 제안을 입력합니다. 문서의 관련 부분에 대한 링크를 포함합니다.

- 대화 상자 하단에서 생성 을 클릭합니다.

1장. 기본 네트워크 액세스 구성 및 관리

이 섹션에서는 Red Hat Enterprise Linux에서 네트워크 설정을 구성하는 방법에 대한 기본 옵션만 설명합니다.

1.1. 그래픽 설치 모드에서 네트워크 및 호스트 이름 구성

다음 프로세스의 단계에 따라 네트워크 및 호스트 이름을 구성합니다.

절차

- Installation Summary (설치 요약) 창에서 Network and Host Name(네트워크 및 호스트 이름)을 클릭합니다.

왼쪽 창의 목록에서 인터페이스를 선택합니다. 세부 정보는 오른쪽 창에 표시됩니다.

참고영구적인 이름의 네트워크 장치를 식별하는 데 사용되는 네트워크 장치 이름 지정 표준 유형은

em1및wl3sp0입니다. 이러한 표준에 대한 자세한 내용은 네트워킹 구성 및 관리를 참조하십시오.ON/OFF(켜기/끄기) 스위치를 토글하여 선택한 인터페이스를 활성화하거나 비활성화합니다.

참고설치 프로그램은 로컬에서 액세스할 수 있는 인터페이스를 자동으로 감지하고 수동으로 추가하거나 제거할 수 없습니다.

- + 를 클릭하여 가상 네트워크 인터페이스를 추가합니다. 이 인터페이스 중 하나는 다음과 같습니다. 팀, 본딩, 브리지 또는 VLAN.

- 가상 인터페이스를 제거하려면 - 를 클릭합니다.

- Configure(구성 )를 클릭하여 기존 인터페이스(가상 및 물리적 모두)의 IP 주소, DNS 서버 또는 라우팅 구성과 같은 설정을 변경합니다.

Host Name(호스트 이름) 필드에 시스템의 호스트 이름을 입력합니다.

참고-

호스트 이름은

hostname.domainname형식의 FQDN(정규화된 도메인 이름) 또는 도메인이 없는 짧은 호스트 이름일 수 있습니다. 많은 네트워크에는 도메인 이름을 사용하여 연결된 시스템을 자동으로 제공하는 DHCP(Dynamic Host Configuration Protocol) 서비스가 있습니다. DHCP 서비스에서 이 시스템에 도메인 이름을 할당할 수 있도록 하려면 짧은 호스트 이름만 지정합니다. -

고정 IP 및 호스트 이름 구성을 사용하는 경우 계획된 시스템 사용 사례에 따라 짧은 이름 또는 FQDN을 사용할지 여부에 따라 달라집니다. Red Hat Identity Management는 프로비저닝 중에 FQDN을 구성하지만 일부 타사 소프트웨어 제품에는 짧은 이름이 필요할 수 있습니다. 두 경우 모두 모든 상황에서 두 양식의 가용성을 보장하기 위해

IP FQDN short-alias형식으로/etc/hosts의 호스트에 대한 항목을 추가합니다. -

localhost값은 대상 시스템에 대한 특정 정적 호스트 이름이 구성되어 있지 않으며, 설치된 시스템의 실제 호스트 이름은 DHCP 또는 DNS를 사용하는 NetworkManager를 사용하여 네트워크 구성을 처리하는 동안 구성됩니다. -

호스트 이름은 영숫자 문자만 포함할 수 있으며

-또는 ... 호스트 이름은 64자 이상이어야 합니다. 호스트 이름은-및 로 시작하거나 종료할 수 없습니다.DNS를 준수하려면 FQDN의 각 부분이 63자 미만이어야 하며 점을 포함한 FQDN 길이에 255자를 초과해서는 안 됩니다.

-

호스트 이름은

- Apply(적용 )를 클릭하여 설치 프로그램 환경에 호스트 이름을 적용합니다.

- 또는 Network and Hostname(네트워크 및 호스트 이름 ) 창에서 플레이버 옵션을 선택할 수 있습니다. 오른쪽 창에서 Select network (네트워크 선택)를 클릭하여 사용 가능한 연결을 선택하고 필요한 경우 암호를 입력하고 Done(완료)을 클릭합니다.

추가 리소스

1.2. nmcli를 사용하여 이더넷 연결 구성

이더넷을 통해 호스트를 네트워크에 연결하는 경우 nmcli 유틸리티를 사용하여 명령줄에서 연결의 설정을 관리할 수 있습니다.

사전 요구 사항

- 물리적 또는 가상 이더넷 NIC(네트워크 인터페이스 컨트롤러)가 서버 구성에 있습니다.

절차

NetworkManager 연결 프로필을 나열합니다.

# nmcli connection show NAME UUID TYPE DEVICE Wired connection 1 a5eb6490-cc20-3668-81f8-0314a27f3f75 ethernet enp1s0기본적으로 NetworkManager는 호스트의 각 NIC에 대한 프로필을 생성합니다. 이 NIC를 특정 네트워크에만 연결하려는 경우 자동으로 생성된 프로필을 조정합니다. 이 NIC를 다른 설정으로 네트워크에 연결하려는 경우 각 네트워크에 대한 개별 프로필을 생성합니다.

추가 연결 프로필을 생성하려면 다음을 입력합니다.

# nmcli connection add con-name <connection-name> ifname <device-name> type ethernet기존 프로필을 수정하려면 이 단계를 건너뜁니다.

선택 사항: 연결 프로필의 이름을 변경합니다.

# nmcli connection modify "Wired connection 1" connection.id "Internal-LAN"프로필이 여러 개인 호스트에서 의미 있는 이름을 사용하면 프로필의 용도를 쉽게 식별할 수 있습니다.

연결 프로필의 현재 설정을 표시합니다.

# nmcli connection show Internal-LAN ... connection.interface-name: enp1s0 connection.autoconnect: yes ipv4.method: auto ipv6.method: auto ...IPv4 설정을 구성합니다.

DHCP를 사용하려면 다음을 입력합니다.

# nmcli connection modify Internal-LAN ipv4.method autoipv4.method가 이미auto(기본값)로 설정된 경우 이 단계를 건너뜁니다.정적 IPv4 주소, 네트워크 마스크, 기본 게이트웨이, DNS 서버 및 검색 도메인을 설정하려면 다음을 입력합니다.

# nmcli connection modify Internal-LAN ipv4.method manual ipv4.addresses 192.0.2.1/24 ipv4.gateway 192.0.2.254 ipv4.dns 192.0.2.200 ipv4.dns-search example.com

IPv6 설정을 구성합니다.

SLAAC(상태 비저장 주소 자동 구성)를 사용하려면 다음을 입력합니다.

# nmcli connection modify Internal-LAN ipv6.method autoipv6.method가 이미auto(기본값)로 설정된 경우 이 단계를 건너뜁니다.정적 IPv6 주소, 네트워크 마스크, 기본 게이트웨이, DNS 서버 및 검색 도메인을 설정하려면 다음을 입력합니다.

# nmcli connection modify Internal-LAN ipv6.method manual ipv6.addresses 2001:db8:1::fffe/64 ipv6.gateway 2001:db8:1::fffe ipv6.dns 2001:db8:1::ffbb ipv6.dns-search example.com

프로필의 다른 설정을 사용자 지정하려면 다음 명령을 사용합니다.

# nmcli connection modify <connection-name> <setting> <value>값을 따옴표로 묶거나 spaces로 묶습니다.

프로필을 활성화합니다.

# nmcli connection up Internal-LAN

검증

NIC의 IP 설정을 표시합니다.

# ip address show enp1s0 2: enp1s0: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc fq_codel state UP group default qlen 1000 link/ether 52:54:00:17:b8:b6 brd ff:ff:ff:ff:ff:ff inet 192.0.2.1/24 brd 192.0.2.255 scope global noprefixroute enp1s0 valid_lft forever preferred_lft forever inet6 2001:db8:1::fffe/64 scope global noprefixroute valid_lft forever preferred_lft foreverIPv4 기본 게이트웨이를 표시합니다.

# ip route show default default via 192.0.2.254 dev enp1s0 proto static metric 102IPv6 기본 게이트웨이를 표시합니다.

# ip -6 route show default default via 2001:db8:1::ffee dev enp1s0 proto static metric 102 pref mediumDNS 설정을 표시합니다.

# cat /etc/resolv.conf search example.com nameserver 192.0.2.200 nameserver 2001:db8:1::ffbb여러 연결 프로필이 동시에 활성화된 경우

이름 서버항목의 순서는 이러한 프로필의 DNS 우선 순위 값과 연결 유형에 따라 달라집니다.ping유틸리티를 사용하여 이 호스트가 다른 호스트에 패킷을 보낼 수 있는지 확인합니다.# ping <host-name-or-IP-address>

문제 해결

- 네트워크 커넥터가 호스트와 스위치에 연결되어 있는지 확인합니다.

- 링크 실패가 이 호스트에만 있는지 또는 동일한 스위치에 연결된 다른 호스트에 있는지 확인합니다.

- 네트워크 케이블과 네트워크 인터페이스가 예상대로 작동하는지 확인합니다. 하드웨어 진단 단계를 수행하고 결함 케이블 및 네트워크 인터페이스 카드를 교체합니다.

- 디스크의 구성이 장치의 구성과 일치하지 않는 경우 NetworkManager를 시작하거나 다시 시작하면 장치 구성이 반영되는 메모리 내 연결이 생성됩니다. 자세한 내용과 이 문제를 방지하는 방법은 NetworkManager 서비스 솔루션을 다시 시작한 후 NetworkManager 연결 중복을 참조하십시오.

추가 리소스

-

nm-settings(5)매뉴얼 페이지 - 기본 게이트웨이를 제공하기 위해 특정 프로필을 사용하지 않도록 NetworkManager 구성

- DNS 서버 순서 구성

1.3. nmtui를 사용하여 이더넷 연결 구성

이더넷을 통해 호스트를 네트워크에 연결하는 경우 nmtui 애플리케이션을 사용하여 텍스트 기반 사용자 인터페이스에서 연결의 설정을 관리할 수 있습니다. nmtui 를 사용하여 새 프로필을 만들고 그래픽 인터페이스 없이 호스트에서 기존 프로필을 업데이트합니다.

nmtui:

- 커서 키를 사용하여 이동합니다.

- 버튼을 선택하고 Enter 를 누릅니다.

- 스페이스 를 사용하여 확인란을 선택하고 선택 취소합니다.

사전 요구 사항

- 물리적 또는 가상 이더넷 NIC(네트워크 인터페이스 컨트롤러)가 서버 구성에 있습니다.

절차

연결에 사용하려는 네트워크 장치 이름을 모르는 경우 사용 가능한 장치를 표시합니다.

# nmcli device status DEVICE TYPE STATE CONNECTION enp1s0 ethernet unavailable -- ...

nmtui

시작:# nmtui- Edit a connection 을 선택하고 Enter 를 누릅니다.

새 연결 프로필을 추가하거나 기존 프로필을 수정할지 선택합니다.

새 프로필을 생성하려면 다음을 수행합니다.

- Add (추가) 버튼을 누릅니다.

- 네트워크 유형 목록에서 이더넷 을 선택하고 Enter 키를 누릅니다.

- 기존 프로필을 수정하려면 목록에서 프로필을 선택하고 Enter 키를 누릅니다.

선택 사항: 연결 프로필의 이름을 업데이트합니다.

프로필이 여러 개인 호스트에서 의미 있는 이름을 사용하면 프로필의 용도를 쉽게 식별할 수 있습니다.

- 새 연결 프로필을 생성하는 경우 장치 필드에 네트워크 장치 이름을 입력합니다.

환경에 따라 그에 따라

IPv4 구성 및영역에서 IP 주소 설정을 구성합니다. 이를 위해 다음 영역 옆에 있는 버튼을 누른 후 다음을 선택합니다.IPv6 구성- 비활성화됨 (이 연결에 IP 주소가 필요하지 않은 경우).

- 자동으로 DHCP 서버가 이 NIC에 IP 주소를 동적으로 할당하는 경우입니다.

수동: 네트워크에 고정 IP 주소 설정이 필요한 경우입니다. 이 경우 추가 필드를 채워야 합니다.

- 추가 필드를 표시하도록 구성할 프로토콜 옆에 있는 Show 버튼을 누릅니다.

주소 옆에 있는 추가 버튼을 누른 다음 CIDR(Classless Inter-Domain Routing) 형식으로 IP 주소와 서브넷 마스크를 입력합니다.

서브넷 마스크를 지정하지 않으면 NetworkManager는 IPv4 주소에 대해

/32서브넷 마스크를 설정하고 IPv6 주소에 대해/64를 설정합니다.- 기본 게이트웨이의 주소를 입력합니다.

- DNS 서버 옆에 있는 추가 버튼을 누른 후 DNS 서버 주소를 입력합니다.

- 검색 도메인 옆에 있는 추가 버튼을 누른 후 DNS 검색 도메인을 입력합니다.

그림 1.1. 고정 IP 주소 설정이 포함된 이더넷 연결 예

- OK 버튼을 눌러 새 연결을 만들고 자동으로 활성화합니다.

- 뒤로 버튼을 눌러 메인 메뉴로 돌아갑니다.

-

Quit 를 선택하고 Enter 를 눌러

nmtui애플리케이션을 종료합니다.

검증

NIC의 IP 설정을 표시합니다.

# ip address show enp1s0 2: enp1s0: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc fq_codel state UP group default qlen 1000 link/ether 52:54:00:17:b8:b6 brd ff:ff:ff:ff:ff:ff inet 192.0.2.1/24 brd 192.0.2.255 scope global noprefixroute enp1s0 valid_lft forever preferred_lft forever inet6 2001:db8:1::fffe/64 scope global noprefixroute valid_lft forever preferred_lft foreverIPv4 기본 게이트웨이를 표시합니다.

# ip route show default default via 192.0.2.254 dev enp1s0 proto static metric 102IPv6 기본 게이트웨이를 표시합니다.

# ip -6 route show default default via 2001:db8:1::ffee dev enp1s0 proto static metric 102 pref mediumDNS 설정을 표시합니다.

# cat /etc/resolv.conf search example.com nameserver 192.0.2.200 nameserver 2001:db8:1::ffbb여러 연결 프로필이 동시에 활성화된 경우

이름 서버항목의 순서는 이러한 프로필의 DNS 우선 순위 값과 연결 유형에 따라 달라집니다.ping유틸리티를 사용하여 이 호스트가 다른 호스트에 패킷을 보낼 수 있는지 확인합니다.# ping <host-name-or-IP-address>

문제 해결

- 네트워크 커넥터가 호스트와 스위치에 연결되어 있는지 확인합니다.

- 링크 실패가 이 호스트에만 있는지 또는 동일한 스위치에 연결된 다른 호스트에 있는지 확인합니다.

- 네트워크 케이블과 네트워크 인터페이스가 예상대로 작동하는지 확인합니다. 하드웨어 진단 단계를 수행하고 결함 케이블 및 네트워크 인터페이스 카드를 교체합니다.

- 디스크의 구성이 장치의 구성과 일치하지 않는 경우 NetworkManager를 시작하거나 다시 시작하면 장치 구성이 반영되는 메모리 내 연결이 생성됩니다. 자세한 내용과 이 문제를 방지하는 방법은 NetworkManager 서비스 솔루션을 다시 시작한 후 NetworkManager 연결 중복을 참조하십시오.

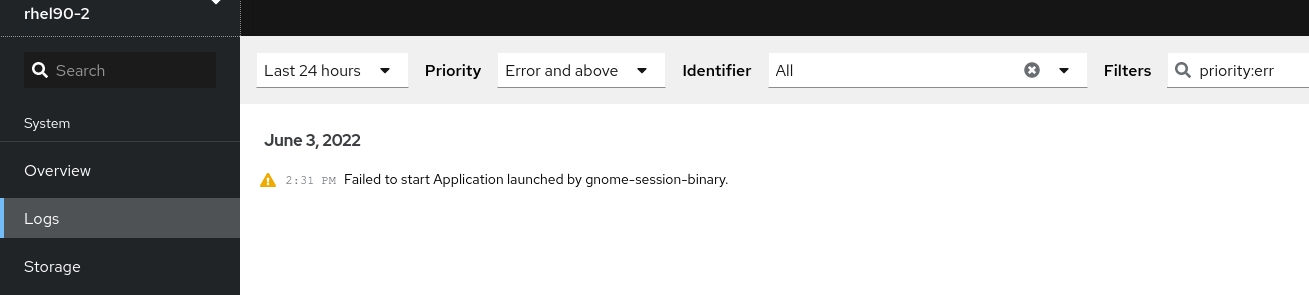

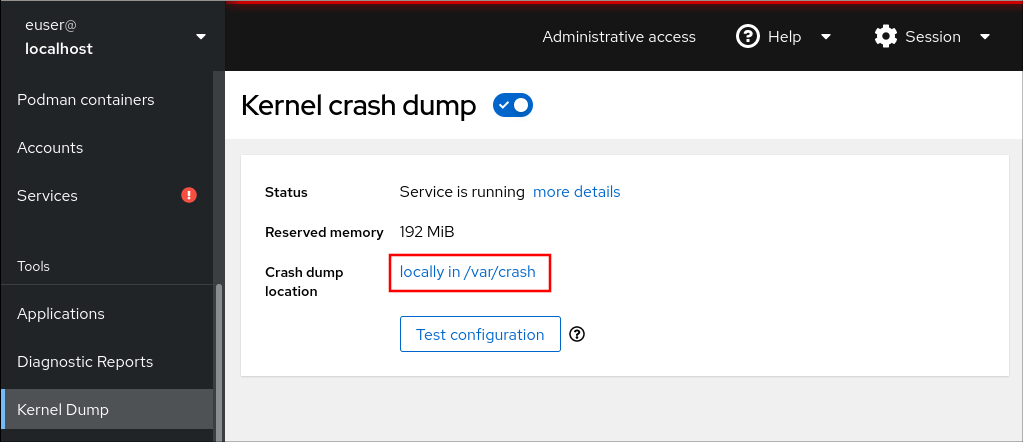

1.4. RHEL 웹 콘솔에서 네트워킹 관리

웹 콘솔에서 Networking (네트워킹) 메뉴를 사용하면 다음을 수행할 수 있습니다.

- 현재 수신 및 전송된 패킷을 표시하려면

- 사용 가능한 네트워크 인터페이스의 가장 중요한 특성을 표시

- 네트워킹 로그의 콘텐츠를 표시합니다.

- 다양한 유형의 네트워크 인터페이스를 추가하려면 (bond, team, bridge, VLAN)

그림 1.2. RHEL 웹 콘솔에서 네트워킹 관리

1.5. RHEL 시스템 역할을 사용하여 네트워킹 관리

네트워크 역할을 사용하여 여러 대상 머신에서 네트워킹 연결을 구성할 수 있습니다.

네트워크 역할을 사용하면 다음 유형의 인터페이스를 구성할 수 있습니다.

- 이더넷

- 브릿지

- 본딩됨

- VLAN

- MacVLAN

- InfiniBand

각 호스트에 필요한 네트워킹 연결은 network_connections 변수 내의 목록으로 제공됩니다.

네트워크 역할은 network _connections 변수에 지정된 대로 타겟 시스템의 모든 연결 프로필을 업데이트하거나 생성합니다. 따라서 옵션이 시스템에만 있지만 network_connections 변수에 없는 경우 네트워크 역할은 지정된 프로필에서 옵션을 제거합니다.

다음 예제에서는 네트워크 역할을 적용하여 필수 매개 변수를 사용한 이더넷 연결이 있는지 확인하는 방법을 보여줍니다.

필수 매개 변수를 사용한 이더넷 연결을 설정하기 위해 네트워크 역할을 적용하는 예제

# SPDX-License-Identifier: BSD-3-Clause

---

- hosts: managed-node-01.example.com

vars:

network_connections:

# Create one Ethernet profile and activate it.

# The profile uses automatic IP addressing

# and is tied to the interface by MAC address.

- name: prod1

state: up

type: ethernet

autoconnect: yes

mac: "00:00:5e:00:53:00"

mtu: 1450

roles:

- rhel-system-roles.network

1.6. 추가 리소스

2장. 시스템 등록 및 서브스크립션 관리

서브스크립션은 운영 체제 자체를 포함하여 Red Hat Enterprise Linux에 설치된 제품을 다룹니다.

Red Hat Content Delivery Network 서브스크립션을 사용하여 다음을 추적할 수 있습니다.

- 등록된 시스템

- 시스템에 제품이 설치되어 있습니다

- 설치된 제품에 첨부된 서브스크립션

2.1. 설치 후 시스템 등록

설치 프로세스 중에 시스템을 등록하지 않은 경우 다음 절차에 따라 시스템을 등록하십시오.

사전 요구 사항

- Red Hat 고객 포털에서 유효한 사용자 계정.

- Red Hat 로그인 생성 페이지를 참조하십시오.

- RHEL 시스템용 활성 서브스크립션.

- 설치 프로세스에 대한 자세한 내용은 표준 RHEL 8 설치 수행을 참조하십시오.

절차

한 단계로 시스템을 등록하고 자동으로 서브스크립션합니다.

# subscription-manager register --username <username> --password <password> --auto-attach Registering to: subscription.rhsm.redhat.com:443/subscription The system has been registered with ID: 37to907c-ece6-49ea-9174-20b87ajk9ee7 The registered system name is: client1.idm.example.com Installed Product Current Status: Product Name: Red Hat Enterprise Linux for x86_64 Status: Subscribed명령을 실행하면 Red Hat 고객 포털 사용자 이름과 암호를 입력하라는 메시지가 표시됩니다.

등록 프로세스가 실패하면 시스템을 특정 풀에 등록할 수 있습니다. 수행하는 방법에 대한 지침을 보려면 다음 단계를 따르십시오.

필요한 서브스크립션의 풀 ID를 확인합니다.

# subscription-manager list --available이 명령은 Red Hat 계정에 사용 가능한 모든 서브스크립션을 표시합니다. 모든 서브스크립션에 대해 풀 ID를 포함하여 다양한 특성이 표시됩니다.

pool_id 를 이전 단계에서 확인한 풀 ID로 교체하여 시스템에 적절한 서브스크립션을 연결합니다.

# subscription-manager attach --pool=pool_id

Red Hat Insights에 시스템을 등록하려면 rhc connect 유틸리티를 사용할 수 있습니다. 원격 호스트 구성 설정을 참조하십시오.

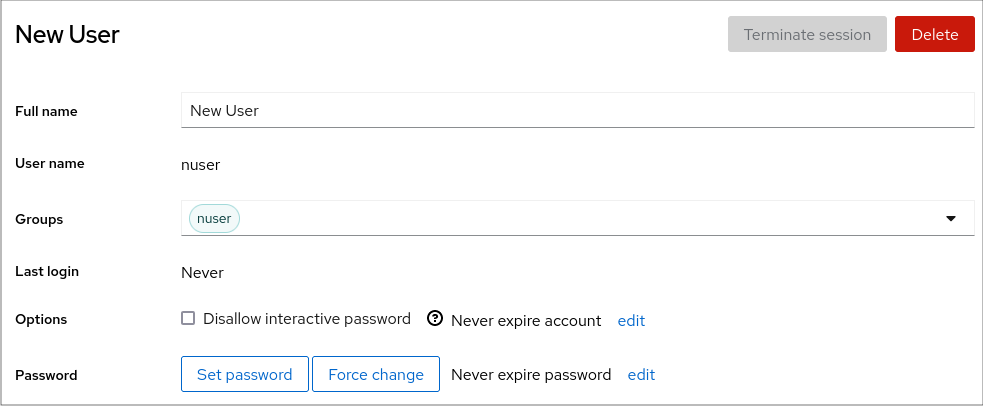

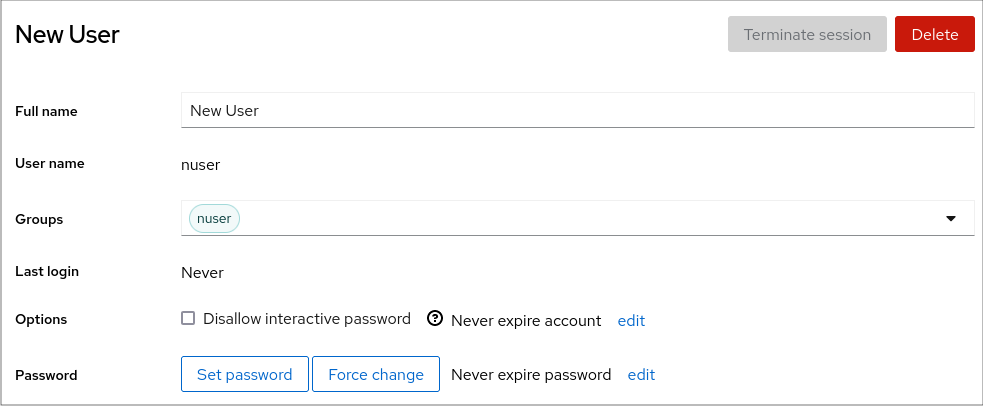

2.2. 웹 콘솔에서 인증 정보로 서브스크립션 등록

RHEL 웹 콘솔을 사용하여 계정 자격 증명에 새로 설치된 Red Hat Enterprise Linux를 등록하려면 다음 단계를 사용하십시오.

사전 요구 사항

Red Hat 고객 포털에서 유효한 사용자 계정.

Red Hat 로그인 생성 페이지를 참조하십시오.

- RHEL 시스템용 활성 서브스크립션.

절차

- RHEL 웹 콘솔에 로그인합니다. 자세한 내용은 웹 콘솔에 로그인을 참조하십시오.

개요 페이지의 Health filed에서 Not registered 경고를 클릭하거나 메인 메뉴에서 Subscriptions (서브스크립션)를 클릭하여 서브스크립션 정보를 페이지로 이동합니다.

.

.

Overview filed에서 Register 를 클릭합니다.

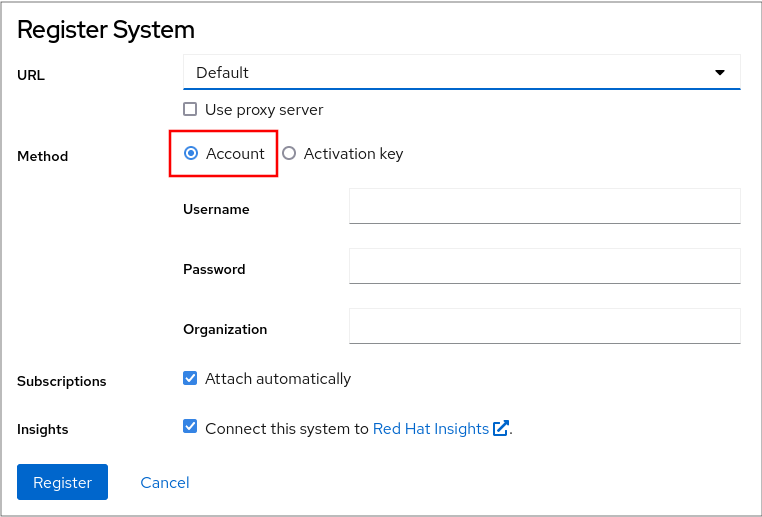

시스템 등록 대화 상자에서 계정 자격 증명을 사용하여 등록할 항목을 선택합니다.In the Register system dialog box, select that you want to register using your account credentials.

- 사용자 이름을 입력합니다.

- 암호를 입력합니다.

필요한 경우 조직의 이름 또는 ID를 입력합니다.

Red Hat 고객 포털에서 두 개 이상의 조직에 속해 있는 경우 조직 이름 또는 조직 ID를 추가해야 합니다. 조직 ID를 얻으려면 Red Hat 연락처로 이동하십시오.

- 시스템을 Red Hat Insights에 연결하지 않으려면 Insights 확인란을 지웁니다.

- Register 버튼을 클릭합니다.

이 시점에서 Red Hat Enterprise Linux Enterprise Linux 시스템이 성공적으로 등록되었습니다.

2.3. GNOME에서 Red Hat 계정을 사용하여 시스템 등록

다음 절차의 단계에 따라 시스템을 Red Hat 계정에 등록하십시오.

사전 요구 사항

Red Hat 고객 포털에서 유효한 계정.

새 사용자 등록은 Create a Red Hat Login (Red Hat 로그인 만들기) 페이지를 참조하십시오.

절차

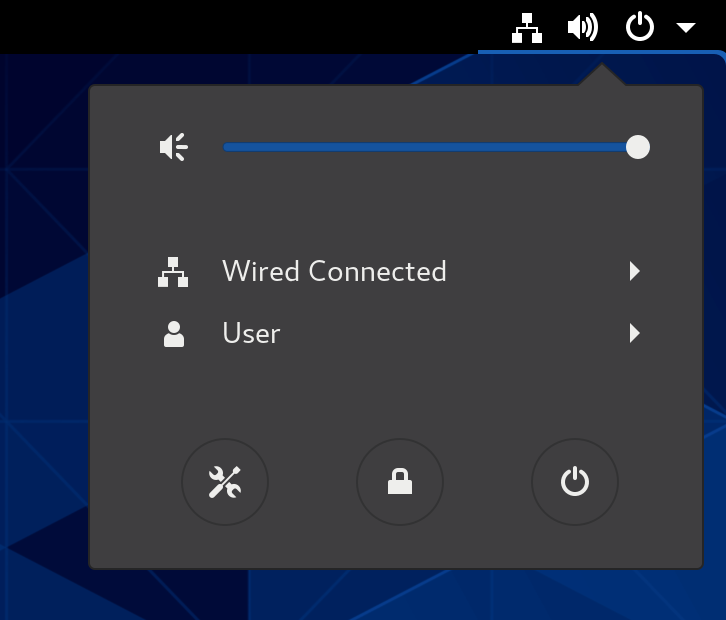

오른쪽 상단에 있는 시스템 메뉴를 열고 Settings 아이콘을 클릭합니다.

- Details → About (세부 정보 정보) 섹션에서 Register(등록 )를 클릭합니다.

- Registration Server (등록 서버)를 선택합니다.

- Red Hat 서버를 사용하지 않는 경우 URL 필드에 서버 주소를 입력합니다.

- 등록 유형 메뉴에서 Red Hat 계정을 선택합니다.

등록 정보 아래 :

- 로그인 필드에 Red Hat 계정 사용자 이름을 입력합니다.

- 암호 필드에 Red Hat 계정 암호를 입력합니다.

- Organization (조직) 필드에 조직 이름을 입력합니다.

- Register(등록 )를 클릭합니다.

2.4. GNOME에서 활성화 키를 사용하여 시스템 등록

이 절차의 단계에 따라 시스템을 활성화 키에 등록합니다. 조직 관리자로부터 활성화 키를 가져올 수 있습니다.

사전 요구 사항

활성화 키 또는 키.

새 활성화 키를 생성하려면 활성화 키 페이지를 참조하십시오.

절차

오른쪽 상단에 있는 시스템 메뉴를 열고 Settings 아이콘을 클릭합니다.

- Details → About (세부 정보 정보) 섹션에서 Register(등록 )를 클릭합니다.

- Registration Server (등록 서버)를 선택합니다.

- Red Hat 서버를 사용하지 않는 경우 URL 필드에 서버 주소를 입력합니다.

- Registration Type(등록 유형 ) 메뉴에서 Activation Keys (활성화 키)를 선택합니다.

등록 정보 아래 :

활성화 키 필드에 활성화 키를 입력합니다.

키를 쉼표(

,)로 구분합니다.- 조직 필드에 조직의 이름 또는 ID를 입력합니다.

- Register(등록 )를 클릭합니다.

2.5. 설치 프로그램 GUI를 사용하여 RHEL 8 등록

RHEL 설치 프로그램 GUI를 사용하여 Red Hat Enterprise Linux 8을 등록하려면 다음 단계를 사용하십시오.

사전 요구 사항

- Red Hat 고객 포털에 유효한 사용자 계정이 있어야 합니다. Red Hat 로그인 생성 페이지를 참조하십시오.

- 유효한 활성화 키 및 조직 ID가 있습니다.

절차

- 설치 요약 화면에서 소프트웨어에서 Red Hat에 연결을 클릭합니다.

- 계정 또는 활성화 키 옵션을 사용하여 Red Hat 계정을 인증합니다.

선택 사항: Set System Purpose (시스템 용도 설정) 필드에서 드롭다운 메뉴에서 설정할 Role,SLA, Usage 특성을 선택합니다.

현재 Red Hat Enterprise Linux 8 시스템이 성공적으로 등록되었습니다.

3장. Red Hat 지원에 액세스

이 섹션에서는 Red Hat 지원 및 sosreport 를 사용하여 문제를 효과적으로 해결하는 방법을 설명합니다.

Red Hat으로부터 지원을 받으려면 서브스크립션이 제공되는 모든 항목에 액세스할 수 있는 Red Hat 고객 포털 을 사용하십시오.

3.1. Red Hat 고객 포털을 통해 Red Hat 지원 요청

다음 섹션에서는 Red Hat 고객 포털을 사용하여 도움을 얻는 방법에 대해 설명합니다.

사전 요구 사항

- Red Hat 고객 포털에서 유효한 사용자 계정. Red Hat 로그인 생성 단원 을 참조하십시오.

- RHEL 시스템용 활성 서브스크립션.

절차

Red Hat 지원에 액세스 :

- 새 지원 사례 열기.

- Red Hat 전문가와 함께 실시간 채팅 시작.

- 전화 문의 또는 이메일 전송은 Red Hat 전문가에게 문의하십시오.

3.2. sosreport를 사용하여 문제 해결

sosreport 명령은 Red Hat Enterprise Linux 시스템에서 구성 세부 정보, 시스템 정보 및 진단 정보를 수집합니다.

다음 섹션에서는 sosreport 명령을 사용하여 지원 사례에 대한 보고서를 생성하는 방법을 설명합니다.

사전 요구 사항

- Red Hat 고객 포털에서 유효한 사용자 계정. Red Hat 로그인 생성 단원 을 참조하십시오.

- RHEL 시스템용 활성 서브스크립션.

- 지원 케이스 번호.

절차

sos패키지를 설치합니다.# yum install sos참고Red Hat Enterprise Linux의 기본 최소 설치에는

sosreport명령을 제공하는sos패키지가 포함되지 않습니다.보고서를 생성합니다.

# sosreport지원 사례에 보고서를 첨부합니다.

Red Hat 지원 케이스에 파일을 첨부하려면 어떻게 해야 합니까? 자세한 내용은 Red Hat 지식베이스 문서.

보고서를 첨부할 때 관련 지원 케이스 수를 입력하라는 메시지가 표시됩니다.

4장. 기본 환경 설정 변경

기본 환경 설정 구성은 설치 프로세스의 일부입니다. 다음 섹션에서는 나중에 변경할 때 안내합니다. 환경의 기본 구성에는 다음이 포함됩니다.

- 날짜 및 시간

- 시스템 로케일

- 키보드 레이아웃

- 언어

4.1. 날짜 및 시간 설정

정확한 시간 보관은 여러 가지 이유로 중요합니다. Red Hat Enterprise Linux에서는 사용자 공간에서 데몬이 실행되는 NTP 프로토콜을 통해 시간 초과를 보장합니다. 사용자 공간 데몬은 커널에서 실행되는 시스템 시계를 업데이트합니다. 시스템 클록은 다양한 시계 소스를 사용하여 시간을 유지할 수 있습니다.

Red Hat Enterprise Linux 8은 chronyd 데몬을 사용하여 NTP 를 구현합니다.chronyd 는 chrony 패키지에서 사용할 수 있습니다. 자세한 내용은 chrony 모음을 사용하여 NTP 구성을 참조하십시오.

4.1.1. 현재 날짜 및 시간 표시

현재 날짜와 시간을 표시하려면 다음 단계 중 하나를 사용합니다.

절차

date명령을 입력합니다.$ date Mon Mar 30 16:02:59 CEST 2020자세한 내용을 보려면

timedatectl명령을 사용합니다.$ timedatectl Local time: Mon 2020-03-30 16:04:42 CEST Universal time: Mon 2020-03-30 14:04:42 UTC RTC time: Mon 2020-03-30 14:04:41 Time zone: Europe/Prague (CEST, +0200) System clock synchronized: yes NTP service: active RTC in local TZ: no

추가 리소스

- 웹 콘솔을 사용하여 시간 설정 구성

-

man date(1)및man timedatectl(1)

4.2. 시스템 로케일 구성

시스템 전체 로케일 설정은 systemd 데몬에서 초기 부팅 시 읽을 수 있는 /etc/locale.conf 파일에 저장됩니다. 개별 프로그램이나 개별 사용자가 재정의하지 않는 한 모든 서비스 또는 사용자는 /etc/locale.conf 에 구성된 로케일 설정을 상속합니다.

절차

사용 가능한 시스템 로케일 설정을 나열하려면 다음을 수행합니다.

$ localectl list-locales C.utf8 aa_DJ aa_DJ.iso88591 aa_DJ.utf8 ...시스템 로케일 설정의 현재 상태를 표시하려면 다음을 수행합니다.

$ localectl status기본 시스템 로케일 설정을 설정하거나 변경하려면

root사용자로localectl set-locale하위 명령을 사용합니다. 예를 들면 다음과 같습니다.# localectl set-locale LANG=en_US

추가 리소스

-

man localectl(1),man locale(7)및man locale.conf(5)

4.3. 키보드 레이아웃 구성

키보드 레이아웃 설정은 텍스트 콘솔 및 그래픽 사용자 인터페이스에 사용되는 레이아웃을 제어합니다.

절차

사용 가능한 키 맵을 나열하려면 다음을 수행합니다.

$ localectl list-keymaps ANSI-dvorak al al-plisi amiga-de amiga-us ...keymaps 설정의 현재 상태를 표시하려면 다음을 수행합니다.

$ localectl status ... VC Keymap: us ...기본 시스템 키맵을 설정하거나 변경하려면 다음을 수행합니다. 예를 들면 다음과 같습니다.

# localectl set-keymap us

추가 리소스

-

man localectl(1),man locale(7)및man locale.conf(5)

4.4. 텍스트 콘솔 모드에서 글꼴 크기 변경

setfont 명령을 사용하여 가상 콘솔에서 글꼴 크기를 변경할 수 있습니다.

글꼴 이름과 함께

setfont명령을 입력합니다. 예를 들면 다음과 같습니다.# setfont /usr/lib/kbd/consolefonts/LatArCyrHeb-19.psfu.gz

setfont 명령은 기본적으로 여러 하드 코딩된 경로를 검색합니다. 따라서 setfont 에는 글꼴의 전체 이름과 경로가 필요하지 않습니다.

가로 및 수직으로 글꼴 크기를 두 배로 늘리려면

-d매개변수를 사용하여setfont명령을 입력합니다.# setfont -d LatArCyrHeb-16

두 배로 늘릴 수 있는 최대 글꼴 크기는 16x16 component입니다.

시스템을 재부팅하는 동안 선택한 글꼴을 유지하려면

/etc/vconsole.conf파일에서FONT변수를 사용합니다. 예를 들면 다음과 같습니다.# cat /etc/vconsole.conf KEYMAP="us" FONT="eurlatgr"'kbd' 패키지로 설치된

kbd-misc패키지에서 다양한 글꼴을 찾을 수 있습니다. 예를 들어, 글꼴LatArCyrHeb에는 다음과 같은 다양한 변형이 있습니다.# rpm -ql kbd-misc | grep LatAr /usr/lib/kbd/consolefonts/LatArCyrHeb-08.psfu.gz /usr/lib/kbd/consolefonts/LatArCyrHeb-14.psfu.gz /usr/lib/kbd/consolefonts/LatArCyrHeb-16+.psfu.gz /usr/lib/kbd/consolefonts/LatArCyrHeb-16.psfu.gz /usr/lib/kbd/consolefonts/LatArCyrHeb-19.psfu.gz

가상 콘솔에서 지원되는 최대 글꼴 크기는 32픽셀입니다. 콘솔에 대한 작은 해상도를 사용하여 글꼴 가독성 문제를 줄일 수 있습니다.

4.5. 추가 리소스

5장. OpenSSH로 두 시스템 간의 보안 통신 사용

SSH(Secure Shell)는 클라이언트-서버 아키텍처를 사용하여 두 시스템 간에 보안 통신을 제공하고 사용자가 서버 호스트 시스템에 원격으로 로그인할 수 있는 프로토콜입니다. FTP 또는 Telnet과 같은 다른 원격 통신 프로토콜과 달리 SSH는 로그인 세션을 암호화하여 침입자가 암호화되지 않은 암호를 연결에서 수집할 수 있습니다.

Red Hat Enterprise Linux에는 일반 openssh 패키지, openssh -server 패키지, 패키지 등 기본 openssh- clientsOpenSSH 패키지가 포함되어 있습니다. OpenSSH 패키지에는 OpenSSH 가 암호화된 통신을 제공할 수 있는 몇 가지 중요한 암호화 라이브러리를 설치하는 OpenSSL 패키지가 있어야 합니다.

5.1. SSH 및 OpenSSH

SSH(Secure Shell)는 원격 시스템에 로그인하고 해당 시스템에서 명령을 실행하는 프로그램입니다. SSH 프로토콜은 비보안 네트워크를 통해 신뢰할 수 없는 두 호스트 간에 안전한 암호화된 통신을 제공합니다. 보안 채널을 통해 X11 연결 및 임의의 TCP/IP 포트를 전달할 수도 있습니다.

SSH 프로토콜은 원격 쉘 로그인 또는 파일 복사에 사용할 때 두 시스템 간 통신 가로채기 및 특정 호스트의 가장과 같은 보안 위협을 완화합니다. 이는 SSH 클라이언트와 서버가 디지털 서명을 사용하여 ID를 확인하기 때문입니다. 또한 클라이언트와 서버 시스템 간의 모든 통신이 암호화됩니다.

호스트 키는 SSH 프로토콜에서 호스트를 인증합니다. 호스트 키는 OpenSSH가 처음 설치될 때 또는 호스트가 처음 부팅될 때 자동으로 생성되는 암호화 키입니다.

OpenSSH는 Linux, UNIX 및 유사한 운영 체제에서 지원하는 SSH 프로토콜 구현입니다. OpenSSH 클라이언트와 서버 모두에 필요한 핵심 파일을 포함합니다. OpenSSH 제품군은 다음 사용자 공간 도구로 구성됩니다.

-

SSH는 원격 로그인 프로그램(SSH 클라이언트)입니다. -

sshd는 OpenSSH SSH 데몬입니다. -

SCP는 안전한 파일 복사 프로그램입니다. -

SFTP는 안전한 파일 전송 프로그램입니다. -

SSH-agent는 개인 키를 캐싱하기 위한 인증 에이전트입니다. -

ssh-add는ssh-agent에 개인 키 ID를 추가합니다. -

SSH-keygen은에 대한 인증 키를 생성, 관리 및 변환합니다.ssh -

ssh-copy-id는 원격 SSH 서버의authorized_keys파일에 로컬 공개 키를 추가하는 스크립트입니다. -

SSH-keyscan은 SSH 공개 호스트 키를 수집합니다.

현재 SSH의 두 가지 버전인 버전 1과 최신 버전 2가 있습니다. RHEL의 OpenSSH 제품군은 SSH 버전 2만 지원합니다. 버전 1에서 알려진 악용에 취약하지 않은 향상된 key-exchange 알고리즘을 가지고 있습니다.

OpenSSH는 RHEL의 핵심 암호화 하위 시스템 중 하나로 시스템 전체 암호화 정책을 사용합니다. 이렇게 하면 기본 구성에서 약한 암호 제품군 및 암호화 알고리즘이 비활성화됩니다. 정책을 수정하려면 관리자는 update-crypto-policies 명령을 사용하여 설정을 조정하거나 시스템 전체 암호화 정책을 수동으로 비활성화해야 합니다.

OpenSSH 제품군은 클라이언트 프로그램(즉, ssh,scp, sftp)과 서버( sshd 데몬)에 대한 두 가지 구성 파일 세트를 사용합니다.

시스템 전체 SSH 구성 정보는 /etc/ssh/ 디렉토리에 저장됩니다. 사용자별 SSH 구성 정보는 사용자 홈 디렉터리의 ~/.ssh/에 저장됩니다. OpenSSH 구성 파일의 자세한 목록은 sshd(8) 도움말 페이지의 FILES 섹션을 참조하십시오.

추가 리소스

-

man -k ssh명령을 사용하여 나열된 도움말 페이지 - 시스템 전체 암호화 정책 사용

5.2. OpenSSH 서버 구성 및 시작

환경 및 OpenSSH 서버를 시작하는 데 필요할 수 있는 기본 구성에는 다음 절차를 사용합니다. 기본 RHEL 설치 후에는 sshd 데몬이 이미 시작되고 서버 호스트 키가 자동으로 생성됩니다.

사전 요구 사항

-

openssh-server패키지가 설치되어 있습니다.

절차

현재 세션에서

sshd데몬을 시작하고 부팅 시 자동으로 시작되도록 설정합니다.# systemctl start sshd # systemctl enable sshd

기본

0.0.0.0(IPv4) 또는 :과 다른 주소를 지정하려면 다음을 수행합니다.(IPv6)/etc/ssh/sshd_config구성 파일에서ListenAddress지시문의 경우 느린 동적 네트워크 구성을 사용하여network-online.target대상 장치에 대한 종속성을sshd.service장치 파일에 추가합니다. 이를 위해 다음 콘텐츠를 사용하여/etc/systemd/system/sshd.service.d/local.conf파일을 만듭니다.[Unit] Wants=network-online.target After=network-online.target

-

/etc/ssh/sshd_config구성 파일의 OpenSSH 서버 설정이 시나리오 요구 사항을 충족하는지 검토합니다. 선택적으로

/etc/issue파일을 편집하여 클라이언트를 인증하기 전에 OpenSSH 서버가 표시하는 시작 메시지를 변경합니다. 예를 들면 다음과 같습니다.Welcome to ssh-server.example.com Warning: By accessing this server, you agree to the referenced terms and conditions.

Banner옵션이/etc/ssh/sshd_config에서 주석 처리되지 않고 해당 값에/etc/issue가 포함되어 있는지 확인하십시오.# less /etc/ssh/sshd_config | grep Banner Banner /etc/issue로그인에 성공한 후 표시되는 메시지를 변경하려면 서버에서

/etc/motd파일을 편집해야 합니다. 자세한 내용은pam_motd도움말 페이지를 참조하십시오.systemd구성을 다시 로드하고sshd를 다시 시작하여 변경 사항을 적용합니다.# systemctl daemon-reload # systemctl restart sshd

검증

sshd데몬이 실행 중인지 확인합니다.# systemctl status sshd ● sshd.service - OpenSSH server daemon Loaded: loaded (/usr/lib/systemd/system/sshd.service; enabled; vendor preset: enabled) Active: active (running) since Mon 2019-11-18 14:59:58 CET; 6min ago Docs: man:sshd(8) man:sshd_config(5) Main PID: 1149 (sshd) Tasks: 1 (limit: 11491) Memory: 1.9M CGroup: /system.slice/sshd.service └─1149 /usr/sbin/sshd -D -oCiphers=aes128-ctr,aes256-ctr,aes128-cbc,aes256-cbc -oMACs=hmac-sha2-256,> Nov 18 14:59:58 ssh-server-example.com systemd[1]: Starting OpenSSH server daemon... Nov 18 14:59:58 ssh-server-example.com sshd[1149]: Server listening on 0.0.0.0 port 22. Nov 18 14:59:58 ssh-server-example.com sshd[1149]: Server listening on :: port 22. Nov 18 14:59:58 ssh-server-example.com systemd[1]: Started OpenSSH server daemon.SSH 클라이언트를 사용하여 SSH 서버에 연결합니다.

# ssh user@ssh-server-example.com ECDSA key fingerprint is SHA256:dXbaS0RG/UzlTTku8GtXSz0S1++lPegSy31v3L/FAEc. Are you sure you want to continue connecting (yes/no/[fingerprint])? yes Warning: Permanently added 'ssh-server-example.com' (ECDSA) to the list of known hosts. user@ssh-server-example.com's password:

추가 리소스

-

sshd(8)및sshd_config(5)도움말 페이지.

5.3. 키 기반 인증을 위한 OpenSSH 서버 설정

시스템 보안을 강화하려면 OpenSSH 서버에서 암호 인증을 비활성화하여 키 기반 인증을 시행합니다.

사전 요구 사항

-

openssh-server패키지가 설치되어 있습니다. -

sshd데몬이 서버에서 실행되고 있습니다.

절차

텍스트 편집기에서

/etc/ssh/sshd_config구성을 엽니다. 예를 들면 다음과 같습니다.# vi /etc/ssh/sshd_configPasswordAuthentication옵션을no로 변경합니다.PasswordAuthentication no

새 기본 설치 이외의 시스템에서

PubkeyAuthentication no가 설정되지 않았으며ChallengeResponseAuthentication지시문이no로 설정되어 있는지 확인합니다. 콘솔 또는 대역 외 액세스를 사용하지 않고 원격으로 연결하는 경우 암호 인증을 비활성화하기 전에 키 기반 로그인 프로세스를 테스트합니다.NFS로 마운트된 홈 디렉토리에서 키 기반 인증을 사용하려면

use_nfs_home_dirsSELinux 부울을 활성화합니다.# setsebool -P use_nfs_home_dirs 1sshd데몬을 다시 로드하여 변경 사항을 적용합니다.# systemctl reload sshd

추가 리소스

-

sshd(8),sshd_config(5)및setsebool(8)도움말 페이지.

5.4. SSH 키 쌍 생성

이 절차를 사용하여 로컬 시스템에 SSH 키 쌍을 생성하고 생성된 공개 키를 OpenSSH 서버에 복사합니다. 서버가 적절하게 구성된 경우 암호를 제공하지 않고 OpenSSH 서버에 로그인할 수 있습니다.

다음 단계를 root로 완료하면 root 만 키를 사용할 수 있습니다.

절차

SSH 프로토콜의 버전 2에 대한 ECDSA 키 쌍을 생성하려면 다음을 수행합니다.

$ ssh-keygen -t ecdsa Generating public/private ecdsa key pair. Enter file in which to save the key (/home/joesec/.ssh/id_ecdsa): Enter passphrase (empty for no passphrase): Enter same passphrase again: Your identification has been saved in /home/joesec/.ssh/id_ecdsa. Your public key has been saved in /home/joesec/.ssh/id_ecdsa.pub. The key fingerprint is: SHA256:Q/x+qms4j7PCQ0qFd09iZEFHA+SqwBKRNaU72oZfaCI joesec@localhost.example.com The key's randomart image is: +---[ECDSA 256]---+ |.oo..o=++ | |.. o .oo . | |. .. o. o | |....o.+... | |o.oo.o +S . | |.=.+. .o | |E.*+. . . . | |.=..+ +.. o | | . oo*+o. | +----[SHA256]-----+ssh-keygen

-tRSA 키 쌍을 생성할 수도 있습니다.ed25519 명령을 입력하여옵션을 사용하여ssh-keygen명령 또는 Ed25519 키 쌍과 함께 -t rsa공개 키를 원격 머신에 복사하려면 다음을 수행합니다.

$ ssh-copy-id joesec@ssh-server-example.com /usr/bin/ssh-copy-id: INFO: attempting to log in with the new key(s), to filter out any that are already installed joesec@ssh-server-example.com's password: ... Number of key(s) added: 1 Now try logging into the machine, with: "ssh 'joesec@ssh-server-example.com'" and check to make sure that only the key(s) you wanted were added.세션에서

ssh-agent프로그램을 사용하지 않는 경우 이전 명령은 가장 최근에 수정된~/.ssh/id*.pub공개 키를 아직 설치하지 않은 경우 복사합니다. 다른 공개 키 파일을 지정하거나ssh-agent로 메모리에 캐시된 키보다 파일의 키 우선 순위를 지정하려면ssh-copy-id명령을-i옵션과 함께 사용합니다.

시스템을 다시 설치하고 이전에 생성된 키 쌍을 유지하려면 ~/.ssh/ 디렉터리를 백업합니다. 다시 설치한 후 홈 디렉터리로 복사합니다. root 를 포함하여 시스템의 모든 사용자에 대해 이 작업을 수행할 수 있습니다.

검증

암호를 제공하지 않고 OpenSSH 서버에 로그인합니다.

$ ssh joesec@ssh-server-example.com Welcome message. ... Last login: Mon Nov 18 18:28:42 2019 from ::1

추가 리소스

-

ssh-keygen(1)및ssh-copy-id(1)도움말 페이지.

5.5. 스마트 카드에 저장된 SSH 키 사용

Red Hat Enterprise Linux를 사용하면 OpenSSH 클라이언트의 스마트 카드에 저장된 RSA 및 ECDSA 키를 사용할 수 있습니다. 다음 절차에 따라 암호 대신 스마트 카드로 인증을 활성화합니다.

사전 요구 사항

-

클라이언트 측에서

opensc패키지가 설치되고pcscd서비스가 실행 중입니다.

절차

PKCS #11 URI를 포함하여 OpenSC PKCS #11 모듈에서 제공하는 모든 키를 나열하고 출력을 keys.pub 파일에 저장합니다.

$ ssh-keygen -D pkcs11: > keys.pub $ ssh-keygen -D pkcs11: ssh-rsa AAAAB3NzaC1yc2E...KKZMzcQZzx pkcs11:id=%02;object=SIGN%20pubkey;token=SSH%20key;manufacturer=piv_II?module-path=/usr/lib64/pkcs11/opensc-pkcs11.so ecdsa-sha2-nistp256 AAA...J0hkYnnsM= pkcs11:id=%01;object=PIV%20AUTH%20pubkey;token=SSH%20key;manufacturer=piv_II?module-path=/usr/lib64/pkcs11/opensc-pkcs11.so

원격 서버(example.com)에서 스마트 카드를 사용하여 인증을 활성화하려면 공개 키를 원격 서버로 전송합니다. 이전 단계에서 만든 key .pub와 함께

ssh-copy-id 명령을 사용하십시오.$ ssh-copy-id -f -i keys.pub username@example.com1단계에서

ssh-keygen -D명령의 출력에서 ECDSA 키를 사용하여 example.com 에 연결하려면 다음과 같이 키를 고유하게 참조하는 URI의 하위 집합만 사용할 수 있습니다.$ ssh -i "pkcs11:id=%01?module-path=/usr/lib64/pkcs11/opensc-pkcs11.so" example.com Enter PIN for 'SSH key': [example.com] $~/.ssh/config파일에서 동일한 URI 문자열을 사용하여 구성을 영구적으로 만들 수 있습니다.$ cat ~/.ssh/config IdentityFile "pkcs11:id=%01?module-path=/usr/lib64/pkcs11/opensc-pkcs11.so" $ ssh example.com Enter PIN for 'SSH key': [example.com] $

OpenSSH는

p11-kit-proxy래퍼를 사용하고 OpenSC PKCS #11 모듈은 PKCS#11 Kit에 등록되므로 이전 명령을 간소화할 수 있습니다.$ ssh -i "pkcs11:id=%01" example.com Enter PIN for 'SSH key': [example.com] $

PKCS #11 URI의 id= 부분을 건너뛰면 OpenSSH는 proxy 모듈에서 사용할 수 있는 모든 키를 로드합니다. 이렇게 하면 필요한 입력 횟수가 줄어듭니다.

$ ssh -i pkcs11: example.com

Enter PIN for 'SSH key':

[example.com] $추가 리소스

- Fedora 28: OpenSSH에서 스마트 카드 지원 개선

-

p11-kit(8),opensc.conf(5),pcscd(8),ssh(1)및ssh-keygen(1)매뉴얼 페이지

5.6. OpenSSH의 보안 강화

다음 팁은 OpenSSH를 사용할 때 보안을 강화하는 데 도움이 됩니다. /etc/ssh/sshd_config OpenSSH 구성 파일의 변경 사항을 적용하려면 sshd 데몬을 다시 로드해야 합니다.

# systemctl reload sshd대부분의 보안 강화 구성 변경으로 최신 알고리즘 또는 암호 제품군을 지원하지 않는 클라이언트와의 호환성이 줄어듭니다.

비보안 연결 프로토콜 비활성화

- SSH를 효과적으로 사용하려면 OpenSSH 제품군으로 대체되는 안전하지 않은 연결 프로토콜을 사용하지 않도록 합니다. 그렇지 않으면 Telnet을 사용하여 로그인할 때 나중에 하나의 세션이 캡처되도록 SSH를 사용하여 사용자 암호를 보호할 수 있습니다. 이러한 이유로 telnet, rsh, rlogin 및 ftp와 같은 비보안 프로토콜을 비활성화하는 것이 좋습니다.

키 기반 인증 활성화 및 암호 기반 인증 비활성화

인증에 대한 암호 비활성화 및 키 쌍만 허용하면 공격 면적이 줄어들고 사용자의 시간도 절약할 수 있습니다. 클라이언트에서

ssh-keygen툴을 사용하여 키 쌍을 생성하고ssh-copy-id유틸리티를 사용하여 OpenSSH 서버의 클라이언트에서 공개 키를 복사합니다. OpenSSH 서버에서 암호 기반 인증을 비활성화하려면/etc/ssh/sshd_config를 편집하고PasswordAuthentication옵션을no로 변경합니다.PasswordAuthentication no

키 유형

ssh-keygen명령은 기본적으로 RSA 키 쌍을 생성하지만-t옵션을 사용하여 ECDSA 또는 Ed25519 키를 생성하도록 지시할 수 있습니다. ECDSA(Elliptic Curve Digital Signature Algorithm)는 동등한 대칭 키 강점에서 RSA보다 더 나은 성능을 제공합니다. 짧은 키도 생성합니다. Ed25519 공개 키 알고리즘은 RSA, DSA 및 ECDSA보다 더 빠르고 안전하며 더 빠릅니다.OpenSSH는 RSA, ECDSA 및 Ed25519 서버 호스트 키가 누락된 경우 자동으로 생성합니다. RHEL에서 호스트 키 생성을 구성하려면

sshd-keygen@.service인스턴스화 서비스를 사용합니다. 예를 들어, RSA 키 유형의 자동 생성을 비활성화하려면 다음을 실행합니다.# systemctl mask sshd-keygen@rsa.service참고cloud-init가 활성화된 이미지에서ssh-keygen단위가 자동으로 비활성화됩니다. 이는ssh-keygen 템플릿서비스가cloud-init툴을 방해하고 호스트 키 생성에 문제가 발생할 수 있기 때문입니다. 이러한 문제를 방지하려면cloud-init가 실행 중인 경우etc/systemd/system/sshd-keygen@.service.d/disable-sshd-keygen-if-cloud-init-active.conf드롭인 구성 파일에서ssh-keygen장치를 비활성화합니다.SSH 연결에 대한 특정 키 유형을 제외하려면

/etc/ssh/sshd_config에서 관련 행을 주석 처리하고sshd서비스를 다시 로드합니다. 예를 들어 Ed25519 호스트 키만 허용하려면 다음을 수행합니다.# HostKey /etc/ssh/ssh_host_rsa_key # HostKey /etc/ssh/ssh_host_ecdsa_key HostKey /etc/ssh/ssh_host_ed25519_key

중요Ed25519 알고리즘은 FIPS-140과 호환되지 않으며 OpenSSH는 FIPS 모드에서 Ed25519 키와 작동하지 않습니다.

기본이 아닌 포트

기본적으로

sshd데몬은 TCP 포트 22에서 수신 대기합니다. 포트를 변경하면 자동화된 네트워크 스캔을 기반으로 시스템이 공격에 노출되는 것을 줄이며 비만에 의해 보안이 향상됩니다./etc/ssh/sshd_config구성 파일에서Port지시문을 사용하여 포트를 지정할 수 있습니다.또한 기본이 아닌 포트를 사용할 수 있도록 기본 SELinux 정책을 업데이트해야 합니다. 이렇게 하려면

policycoreutils-python-utils패키지에서semanage툴을 사용합니다.# semanage port -a -t ssh_port_t -p tcp <port_number>또한

firewalld구성을 업데이트합니다.# firewall-cmd --add-port <port_number>/tcp # firewall-cmd --remove-port=22/tcp # firewall-cmd --runtime-to-permanent

이전 명령에서 < port_number> 를

Port지시문을 사용하여 지정된 새 포트 번호로 바꿉니다.

root 로그인 없음

특정 사용 사례에 root 사용자로 로그인할 가능성이 필요하지 않은 경우

PermitRootLogin구성 지시문을/etc/ssh/sshd_config파일에서no로 설정할 수 있습니다. root 사용자로 로그인할 가능성을 비활성화하여 관리자는 일반 사용자로 로그인한 후 권한이 있는 명령을 실행하는 사용자를 감사한 다음 root 권한을 얻을 수 있습니다.또는 prevent

-password로을 설정합니다.PermitRootLoginPermitRootLogin prohibit-password

이렇게 하면 root로 로그인하는 데 암호를 사용하는 대신 키 기반 인증을 사용하고 무차별 강제 공격을 방지하여 위험을 줄입니다.

X 보안 확장 사용

Red Hat Enterprise Linux 클라이언트의 X 서버는 X 보안 확장을 제공하지 않습니다. 따라서 클라이언트는 X11 전달을 사용하여 신뢰할 수 없는 SSH 서버에 연결할 때 다른 보안 계층을 요청할 수 없습니다. 대부분의 애플리케이션은 이 확장 기능을 사용하여 실행할 수 없습니다.

기본적으로

/etc/ssh/ssh_config.d/05-redhat.conf파일의ForwardX11Trusted옵션은yes로 설정되어 있으며ssh -X remote_machine(신뢰할 수 없는 호스트)과(신뢰할 수 있는 호스트) 명령 사이에 차이가 없습니다.ssh -Y remote_machine시나리오에 X11 전달 기능이 전혀 필요하지 않은 경우

/etc/ssh/sshd_config구성 파일의X11Forwarding지시문을no로 설정합니다.

특정 사용자, 그룹 또는 도메인에 대한 액세스 제한

/etc/ssh/sshd_config구성 파일 서버의AllowUsers및 AllowGroupsAllowUsers 및 AllowGroups를 결합하여 보다 정확하게 액세스를 제한할 수 있습니다. 예를 들면 다음과 같습니다.AllowUsers *@192.168.1.* *@10.0.0.* !*@192.168.1.2 AllowGroups example-group

이전 구성 행은 192.168.1.2 주소가 있는 시스템을 제외하고 192.168.1.* 및 10.0.0.* 서브넷의 모든 사용자로부터의 연결을 허용합니다. 모든 사용자는

example-group그룹에 있어야 합니다. OpenSSH 서버는 다른 모든 연결을 거부합니다.OpenSSH 서버는

/etc/ssh/sshd_config의 모든 Allow 및 Deny 지시문을 전달하는 연결만 허용합니다. 예를 들어AllowUsers지시문이AllowGroups지시문에 나열된 그룹에 포함되지 않은 사용자를 나열하는 경우 사용자는 로그인할 수 없습니다.허용 목록(허용으로 시작하는 디렉터리)을 사용하는 것은 허용 목록(거부로 시작하는 옵션)을 사용하는 것보다 더 안전합니다. allowlists는 새로운 권한 없는 사용자 또는 그룹도 차단하기 때문입니다.

시스템 전체 암호화 정책 변경

OpenSSH는 RHEL 시스템 전체 암호화 정책을 사용하며 기본 시스템 전체 암호화 정책 수준은 현재 위협 모델에 대한 보안 설정을 제공합니다. 암호화 설정을 보다 엄격하게 수행하려면 현재 정책 수준을 변경합니다.

# update-crypto-policies --set FUTURE Setting system policy to FUTURE주의시스템이 인터넷에서 통신할 경우

FUTURE정책의 엄격한 설정으로 인해 상호 운용성 문제에 직면할 수 있습니다.

시스템 전체 암호화 정책을 통해 SSH 프로토콜의 특정 암호만 비활성화할 수도 있습니다. 자세한 내용은 보안 강화 문서의 하위 정책을 사용하여 시스템 전체 암호화 정책 사용자 지정 섹션을 참조하십시오.

OpenSSH 서버에 대한 시스템 전체 암호화 정책을 비활성화하려면 /etc/sysconfig/sshd 파일에서 CRYPTO_POLICY= 변수로 행의 주석을 제거합니다. 이 변경 후 /etc/ssh/sshd_config 파일의 Ciphers, MACs, KexAlgoritms, GSSAPIKexAlgorithms 섹션에 지정하는 값은 재정의되지 않습니다.

자세한 내용은 sshd_config(5) 도움말 페이지를 참조하십시오.

OpenSSH 클라이언트에 대한 시스템 전체 암호화 정책을 비활성화하려면 다음 작업 중 하나를 수행합니다.

-

지정된 사용자의 경우

~/.ssh/를 재정의합니다.config 파일의 사용자별 구성으로 글로벌 ssh_config -

전체 시스템의 경우

/etc/ssh/ssh_config.d/디렉터리에 있는 드롭인 구성 파일에 암호화 정책을 지정하고, 두 자리 숫자 접두사가 5보다 작도록 하여05-redhat.conf파일 앞에 .conf 접미사와.conf접미사(예:04-crypto-policy-override.conf)를 사용합니다.

추가 리소스

-

sshd_config(5),ssh-keygen(1),crypto-policies(7)및update-crypto-policies(8)도움말 페이지. - 보안 강화 문서에서 시스템 전체 암호화 정책 사용.

- ssh 서비스에 대한 특정 알고리즘 및 암호를 비활성화하는 방법만 문서입니다.

5.7. SSH 건너뛰기 호스트를 사용하여 원격 서버에 연결

jump host라고도 하는 중간 서버를 통해 로컬 시스템을 원격 서버에 연결하려면 다음 절차를 사용하십시오.

사전 요구 사항

- 건너뛰기 호스트는 로컬 시스템의 SSH 연결을 허용합니다.

- 원격 서버는 건너뛰기 호스트에서만 SSH 연결을 허용합니다.

절차

로컬 시스템에서

~/.ssh/config파일을 편집하여 건너뛰기를 정의합니다. 예를 들면 다음과 같습니다.Host jump-server1 HostName jump1.example.com

-

Host매개 변수는ssh명령에서 사용할 수 있는 호스트의 이름 또는 별칭을 정의합니다. 이 값은 실제 호스트 이름과 일치할 수 있지만 임의의 문자열일 수도 있습니다. -

HostName매개 변수는 건너뛰기 호스트의 실제 호스트 이름 또는 IP 주소를 설정합니다.

-

ProxyJump지시문을 사용하여 원격 서버 건너뛰기를 로컬 시스템의~/.ssh/config파일에 추가합니다. 예를 들면 다음과 같습니다.Host remote-server HostName remote1.example.com ProxyJump jump-server1

로컬 시스템을 사용하여 이동 서버를 통해 원격 서버에 연결합니다.

$ ssh remote-server이전 명령은 구성 단계 1과 2를 생략하면

ssh -J jump-server1 remote-server명령과 동일합니다.

더 많은 건너뛰기 서버를 지정할 수 있으며 전체 호스트 이름을 제공할 때 구성 파일에 호스트 정의 추가를 건너뛸 수도 있습니다. 예를 들면 다음과 같습니다.

$ ssh -J jump1.example.com,jump2.example.com,jump3.example.com remote1.example.com건너뛰기 서버의 사용자 이름 또는 SSH 포트가 원격 서버의 이름과 포트와 다른 경우 이전 명령에서 호스트 이름 전용 표기법을 변경합니다. 예를 들면 다음과 같습니다.

$ ssh -J johndoe@jump1.example.com:75,johndoe@jump2.example.com:75,johndoe@jump3.example.com:75 joesec@remote1.example.com:220추가 리소스

-

ssh_config(5)및ssh(1)도움말 페이지.

5.8. ssh-agent를 사용하여 SSH 키가 있는 원격 시스템에 연결

SSH 연결을 시작할 때마다 암호를 입력하지 않으려면 ssh-agent 유틸리티를 사용하여 개인 SSH 키를 캐시할 수 있습니다. 개인 키와 암호는 계속 안전합니다.

사전 요구 사항

- 네트워크를 통해 SSH 데몬을 실행하고 연결할 수 있는 원격 호스트가 있습니다.

- IP 주소 또는 호스트 이름 및 자격 증명을 통해 원격 호스트에 로그인합니다.

- 암호를 사용하여 SSH 키 쌍을 생성하고 공개 키를 원격 시스템으로 전송했습니다.

자세한 내용은 SSH 키 쌍 생성 을 참조하십시오.

절차

선택 사항: 키를 사용하여 원격 호스트에 인증할 수 있는지 확인합니다.

SSH를 사용하여 원격 호스트에 연결합니다.

$ ssh example.user1@198.51.100.1 hostname개인 키에 대한 액세스 권한을 부여할 키를 만드는 동안 설정한 암호를 입력합니다.

$ ssh example.user1@198.51.100.1 hostname host.example.com

ssh-agent를 시작합니다.$ eval $(ssh-agent) Agent pid 20062ssh-agent에 키를 추가합니다.$ ssh-add ~/.ssh/id_rsa Enter passphrase for ~/.ssh/id_rsa: Identity added: ~/.ssh/id_rsa (example.user0@198.51.100.12)

검증

선택 사항: SSH를 사용하여 호스트 시스템에 로그인합니다.

$ ssh example.user1@198.51.100.1 Last login: Mon Sep 14 12:56:37 2020암호를 입력할 필요가 없습니다.

5.9. 추가 리소스

-

sshd(8),ssh(1),scp(1),sftp(1),ssh-keygen(1),ssh-copy-id(1),ssh_config(5),sshd_config(5),update-crypto-policies(8)및crypto-policies(7)도움말 페이지. - OpenSSH Home Page

- 비표준 구성을 사용하여 애플리케이션 및 서비스에 대한 SELinux 구성

- firewalld를 사용하여 네트워크 트래픽 제어

6장. 기본 시스템 보안 구성

컴퓨터 보안은 컴퓨터 시스템과 하드웨어, 소프트웨어, 정보 및 서비스의 도난, 손상, 중단 및 오작동으로부터 보호하는 것입니다. 특히 중요한 데이터를 처리하고 비즈니스 트랜잭션을 처리하는 기업에서 컴퓨터 보안이 필수적인 작업인지 확인합니다.

이 섹션에서는 운영 체제를 설치한 후 구성할 수 있는 기본 보안 기능만 설명합니다.

6.1. firewalld 서비스 활성화

방화벽은 구성된 보안 규칙에 따라 들어오고 나가는 네트워크 트래픽을 모니터링하고 제어하는 네트워크 보안 시스템입니다. 방화벽은 일반적으로 신뢰할 수 있는 안전한 내부 네트워크와 다른 외부 네트워크 간의 장벽을 설정합니다.

Red Hat Enterprise Linux에서 방화벽을 제공하는 firewalld 서비스는 설치 중에 자동으로 활성화됩니다.

firewalld 서비스를 활성화하려면 다음 절차를 따르십시오.

절차

firewalld의 현재 상태를 표시합니다 :$ systemctl status firewalld ● firewalld.service - firewalld - dynamic firewall daemon Loaded: loaded (/usr/lib/systemd/system/firewalld.service; disabled; vendor preset: enabled) Active: inactive (dead) ...firewalld가 활성화되어 실행되고 있지 않으면root사용자로 전환하고firewalld서비스를 시작하고 시스템이 다시 시작되면 자동으로 시작합니다.# systemctl enable --now firewalld

검증 단계

firewalld가 실행 중이고 활성화되어 있는지 확인합니다.$ systemctl status firewalld ● firewalld.service - firewalld - dynamic firewall daemon Loaded: loaded (/usr/lib/systemd/system/firewalld.service; enabled; vendor preset: enabled) Active: active (running) ...

추가 리소스

- firewalld 사용 및 구성

-

man firewalld(1)

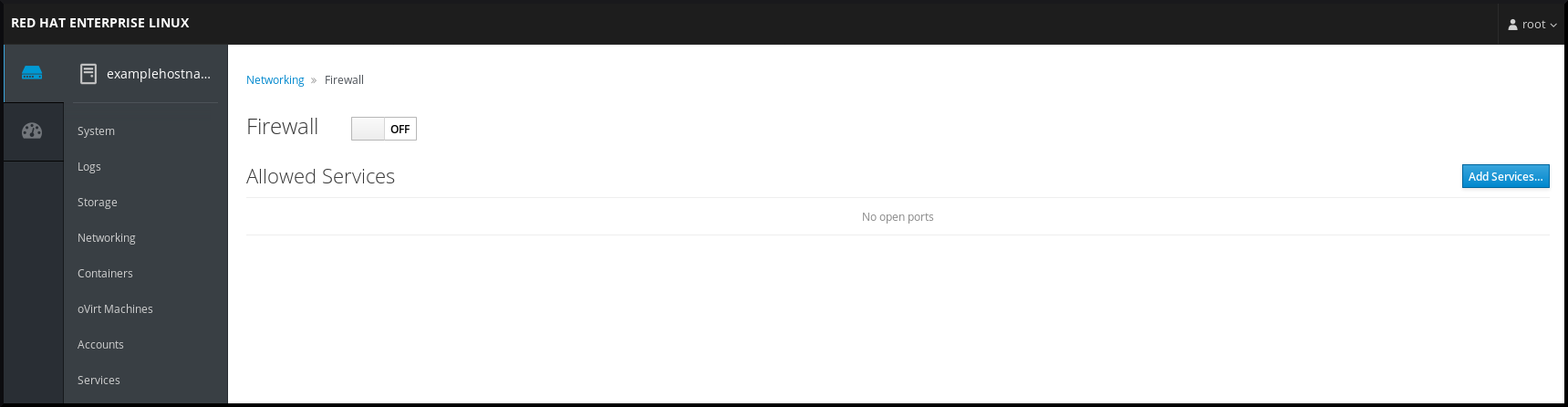

6.2. rhel 8 웹 콘솔에서 방화벽 관리

웹 콘솔에서 firewalld 서비스를 구성하려면 Networking → Firewall (방화벽) 로 이동합니다.

기본적으로 firewalld 서비스는 활성화됩니다.

절차

웹 콘솔에서

firewalld를 활성화하거나 비활성화하려면 Firewall 토글 버튼을 전환합니다.

또한 Add services…를 사용하여 방화벽을 통해 서비스에 대한 보다 세밀한 액세스를 정의할 수 있습니다. 버튼.

6.3. 기본 SELinux 설정 관리

SELinux(Security-Enhanced Linux)는 어떤 프로세스가 어떤 파일, 디렉터리 및 포트에 액세스할 수 있는지를 결정하는 추가 시스템 보안 계층입니다. 이러한 권한은 SELinux 정책에 정의되어 있습니다. 정책은 SELinux 보안 엔진을 안내하는 규칙 집합입니다.

SELinux의 가능한 상태는 다음과 같습니다.

- 비활성화됨

- 활성화됨

SELinux가 활성화되면 다음 모드 중 하나로 실행됩니다.

활성화됨

- 강제

- 허용

강제 모드에서 SELinux는 로드된 정책을 적용합니다. SELinux는 SELinux 정책 규칙을 기반으로 액세스를 거부하고 명시적으로 허용되는 상호 작용만 활성화합니다. 강제 모드는 가장 안전한 SELinux 모드이며 설치 후 기본 모드입니다.

허용 모드에서 SELinux는 로드된 정책을 시행하지 않습니다. SELinux는 액세스를 거부하지 않지만 규칙을 /var/log/audit/audit.log 로그로 손상시키는 작업을 보고합니다. 허용 모드는 설치 중에 기본 모드입니다. 허용 모드는 특정 사례(예: 문제를 해결할 때 유용함)에서도 유용합니다.

추가 리소스

6.4. SELinux의 필수 상태 확인

기본적으로 SELinux는 강제 모드에서 작동합니다. 그러나 특정 시나리오에서는 SELinux를 허용 모드로 설정하거나 비활성화할 수도 있습니다.

시스템을 강제 모드로 유지하는 것이 좋습니다. 디버깅을 위해 SELinux를 허용 모드로 설정할 수 있습니다.

시스템에서 SELinux의 상태와 모드를 변경하려면 다음 절차를 따르십시오.

절차

현재 SELinux 모드를 표시합니다.

$ getenforce일시적으로 SELinux를 설정하려면 다음을 수행합니다.

강제 모드로 전환하려면 다음을 수행합니다.

# setenforce Enforcing허용 모드로 전환하려면 다음을 수행합니다.

# setenforce Permissive참고재부팅 후 SELinux 모드는

/etc/selinux/config구성 파일에 지정된 값으로 설정됩니다.

재부팅 시 지속되도록 SELinux 모드를 설정하려면

/etc/selinux/config구성 파일에서SELINUX변수를 수정합니다.예를 들어 SELinux를 강제 모드로 전환하려면 다음을 수행합니다.

# This file controls the state of SELinux on the system. # SELINUX= can take one of these three values: # enforcing - SELinux security policy is enforced. # permissive - SELinux prints warnings instead of enforcing. # disabled - No SELinux policy is loaded. SELINUX=enforcing ...

주의SELinux를 비활성화하면 시스템 보안이 저하됩니다.

/etc/selinux/config파일에서SELINUX=disabled옵션을 사용하여 SELinux를 비활성화하면 메모리 누수 및 경쟁 조건이 발생하여 커널 패닉이 발생할 수 있기 때문입니다. 대신 커널 명령줄에selinux=0매개 변수를 추가하여 SELinux를 비활성화합니다. 자세한 내용은 부팅 시 SELinux 모드 변경을 참조하십시오.

추가 리소스

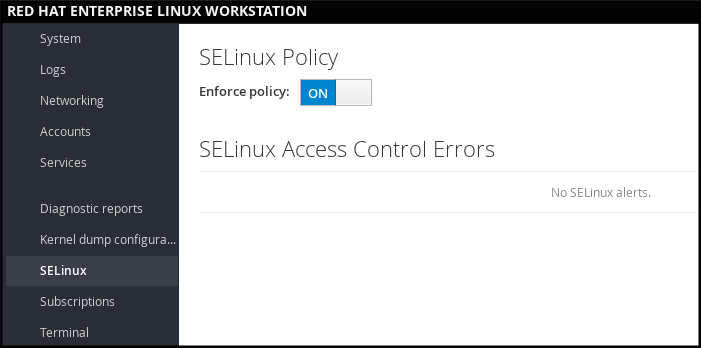

6.5. RHEL 8 웹 콘솔에서 SELinux 모드 전환

SELinux 메뉴 항목의 RHEL 8 웹 콘솔을 통해 SELinux 모드를 설정할 수 있습니다.

기본적으로 웹 콘솔의 SELinux 강제 정책은 이며 SELinux는 강제 모드로 작동합니다. 이를 끄면 SELinux를 허용 모드로 전환합니다. 다음 부팅 시 /etc/sysconfig/selinux 파일에 정의된 구성으로 이 선택 사항이 자동으로 복원됩니다.

절차

웹 콘솔에서 SELinux 메뉴 항목에서 Enforce policy toggle(강제 정책 토글) 버튼을 사용하여 SELinux 강제 정책 켜거나 끕니다.

6.6. 추가 리소스

7장. 소프트웨어 패키지 관리

7.1. RHEL 8의 소프트웨어 관리 툴

RHEL 8에서는 DNF 기술을 기반으로 하는 새로운 버전의 YUM 툴(YUM v4)을 통해 소프트웨어 설치가 활성화됩니다.

업스트림 설명서는 기술을 DNF 로 식별하고 도구는 업스트림에서 DNF 라고 합니다. 결과적으로 RHEL 8의 새로운 YUM 툴에서 반환한 일부 출력에는 DNF 가 표시됩니다.

RHEL 8에서 사용되는 YUM v4 는 DNF 를 기반으로 하지만 RHEL 7에서 사용되는 YUM v3 과 호환됩니다. 소프트웨어 설치의 경우 yum 명령과 대부분의 옵션은 RHEL 7에서처럼 RHEL 8에서와 동일한 방식으로 작동합니다.

선택한 yum 플러그인과 유틸리티는 새 DNF 백엔드로 포팅되었으며 RHEL 7과 동일한 이름으로 설치할 수 있습니다. 패키지는 호환성 심볼릭 링크를 제공하므로 바이너리, 구성 파일 및 디렉터리를 일반적인 위치에서 찾을 수 있습니다.

YUM v3 에서 제공하는 레거시 Python API는 더 이상 사용할 수 없습니다. 플러그인 및 스크립트를 안정적이고 완벽하게 지원되는 YUM v4 (DNF Python API)에서 제공하는 새 API로 마이그레이션할 수 있습니다. 자세한 내용은 DNF API 참조를 참조하십시오.

7.2. 애플리케이션 스트림

RHEL 8에는 Application Streams의 개념이 도입되었습니다. 이제 여러 버전의 사용자 공간 구성 요소가 핵심 운영 체제 패키지보다 더 자주 제공되고 업데이트됩니다. 이는 플랫폼 또는 특정 배포의 기본 안정성에 영향을 주지 않고 Red Hat Enterprise Linux를 사용자 지정할 수 있는 유연성을 향상시킵니다.

Application Streams로 제공되는 구성 요소는 모듈 또는 RPM 패키지로 패키징할 수 있으며 RHEL 8의 AppStream 리포지토리를 통해 제공됩니다. 각 Application Stream에는 RHEL 8과 동일하거나 짧은 라이프사이클이 있으며 특정 애플리케이션에 더 적합합니다. 라이프사이클이 짧은 Application Streams는 Red Hat Enterprise Linux 8 Application Streams 라이프 사이클 페이지에 나열되어 있습니다.

모듈은 논리 단위, 애플리케이션, 언어 스택, 데이터베이스 또는 툴 세트를 나타내는 패키지 컬렉션입니다. 이러한 패키지는 함께 빌드, 테스트, 릴리스됩니다.

모듈 스트림은 Application Stream 구성 요소의 버전을 나타냅니다. 예를 들어 postgresql 모듈에서 두 개의 스트림(버전)의 PostgreSQL 데이터베이스 서버를 사용할 수 있습니다. PostgreSQL 10(기본 스트림) 및 PostgreSQL 9.6. 시스템에는 하나의 모듈 스트림만 설치할 수 있습니다. 개별 컨테이너에서 서로 다른 버전을 사용할 수 있습니다.

자세한 모듈 명령은 사용자 공간 구성 요소 설치, 관리 및 제거 문서에서 설명합니다. AppStream에서 사용 가능한 모듈 목록은 패키지 매니페스트를 참조하십시오.

7.3. 소프트웨어 패키지 검색

yum 을 사용하면 소프트웨어 패키지를 사용하여 전체 작업 세트를 수행할 수 있습니다.

다음 섹션에서는 yum 을 사용하여 다음을 수행하는 방법을 설명합니다.

- 패키지를 검색합니다.

- 패키지 나열.

- 리포지토리를 나열합니다.

- 패키지에 대한 정보를 표시합니다.

- 패키지 그룹 나열.

- yum 입력에서 전역 표현식을 지정합니다.

7.3.1. YUM을 사용하여 패키지 검색

다음 절차에 따라 특정 애플리케이션 또는 기타 콘텐츠를 제공하는 패키지를 찾으십시오.

절차

패키지를 검색하려면 다음을 사용합니다.

# yum search term용어를 패키지와 관련된 용어로 바꿉니다.

yum search명령은 패키지 이름 및 요약 내에서 일치하는 용어를 반환합니다. 그러면 검색이 더 빨라지고 이름을 모르는 패키지를 검색할 수 있지만 관련 용어를 알고 있습니다.패키지 설명 내에서 일치하는 용어를 포함하려면 다음을 사용하십시오.

# yum search --all term용어를 패키지 이름, 요약 또는 설명에서 검색하려는 용어로 바꿉니다.

yum search --all을 사용하면 더 포괄적이지만 느린 검색을 사용할 수 있습니다.

7.3.2. YUM을 사용하여 패키지 나열

다음 절차에 따라 설치 및 사용 가능한 패키지를 나열하십시오.

절차

설치된 모든 패키지 및 사용 가능한 패키지에 대한 정보를 나열하려면 다음을 사용합니다.

# yum list --all시스템에 설치된 모든 패키지를 나열하려면 다음을 사용합니다.

# yum list --installed설치할 수 있는 모든 활성화된 리포지토리의 모든 패키지를 나열하려면 다음을 사용합니다.

# yum list --available

글로벌 표현식을 인수로 추가하여 결과를 필터링할 수 있습니다. yum 입력에서 글로벌 표현식 지정참조

자세한 내용은.

7.3.3. YUM을 사용하여 리포지토리 나열

다음 절차에 따라 활성화된 리포지토리를 나열하고 비활성화합니다.

절차

시스템에서 활성화된 모든 리포지토리를 나열하려면 다음을 사용합니다.

# yum repolist시스템에서 비활성화된 리포지토리를 모두 나열하려면 다음을 사용합니다.

# yum repolist --disabled활성화된 리포지토리와 비활성화된 리포지토리를 모두 나열하려면 다음을 사용합니다.

# yum repolist --all리포지토리에 대한 추가 정보를 나열하려면 다음을 사용합니다.

# yum repoinfo

리포지토리의 ID 또는 이름을 인수로 전달하거나 전역 표현식을 추가하여 결과를 필터링할 수 있습니다. yum 입력에서 글로벌 표현식 지정참조

자세한 내용은.

7.3.4. YUM을 사용하여 패키지 정보 표시

YUM(버전, 릴리스, 크기, 로드된 플러그인 등)을 사용하여 패키지에 대한 다양한 유형의 정보를 표시할 수 있습니다.

절차

하나 이상의 패키지에 대한 정보를 표시하려면 다음을 사용합니다.

# yum info package-namepackage-name 을 패키지 이름으로 바꿉니다.

글로벌 표현식을 인수로 추가하여 결과를 필터링할 수 있습니다. yum 입력에서 글로벌 표현식 지정참조

자세한 내용은.

7.3.5. YUM을 사용하여 패키지 그룹 나열

yum 을 사용하여 설치된 패키지 그룹을 보고 목록 결과를 필터링합니다.

절차

설치되어 사용 가능한 그룹 수를 보려면 다음을 사용합니다.

# yum group summary설치되어 사용 가능한 그룹을 모두 나열하려면 다음을 사용합니다.

# yum group listyum group list명령(--hidden, --available)에 대한 명령줄 옵션을 추가하여 결과를 필터링할 수 있습니다. 사용 가능한 옵션은 도움말 페이지를 참조하십시오.특정 그룹에 포함된 필수 및 선택적 패키지를 나열하려면 다음을 사용합니다.

# yum group info group-namegroup-name 을 그룹 이름으로 바꿉니다.

글로벌 표현식을 인수로 추가하여 결과를 필터링할 수 있습니다. yum 입력에서 글로벌 표현식 지정참조

자세한 내용은.

7.3.6. YUM 입력에서 글로벌 표현식 지정

yum 명령을 사용하면 하나 이상의 glob 표현식 을 인수로 추가하여 결과를 필터링할 수 있습니다. 전역 표현식을 yum 명령에 인수로 전달할 때 이스케이프해야 합니다.

절차

To ensure global expressions are passed to yum as intended, use one of the following methods:

전체 글로벌 표현식을 큰따옴표 또는 단일 따옴표로 묶습니다.

# yum provides "*/file-name"file-name 을 파일 이름으로 바꿉니다.

와일드카드 문자를 백슬래시(\)

문자로이스케이프합니다.# yum provides \*/file-namefile-name 을 파일 이름으로 바꿉니다.

7.4. 소프트웨어 패키지 설치

다음 섹션에서는 yum 을 사용하여 다음을 수행하는 방법을 설명합니다.

- 패키지 설치.

- 패키지 그룹을 설치합니다.

- yum 입력으로 패키지 이름을 지정합니다.

7.4.1. YUM을 사용하여 패키지 설치

패키지 및 모든 패키지 종속성을 설치하려면 다음을 사용합니다.

# yum install package-namepackage-name 을 패키지 이름으로 바꿉니다.

여러 패키지와 해당 종속 패키지를 동시에 설치하려면 다음을 사용합니다.

# yum install package-name-1 package-name-2package-name-1 및 package-name-2 를 패키지 이름으로 바꿉니다.

멀티 라이브러리 시스템 (AMD64, Intel 64 시스템)에 패키지를 설치할 때 패키지 이름에 패키지를 추가하여 패키지의 아키텍처를 지정할 수 있습니다.

# yum install package-name.archpackage-name.arch 를 패키지의 이름 및 아키텍처로 바꿉니다.

설치하려는 바이너리의 이름을 알고 있지만 패키지 이름은 아닌 경우 바이너리의 경로를 인수로 사용할 수 있습니다.

# yum install /usr/sbin/binary-file/usr/sbin/binary-file을 바이너리 파일의 경로로 바꿉니다.yum 은 패키지 목록을 검색하고

/usr/sbin/binary-file을 제공하는 패키지를 찾은 다음 설치 여부를 묻는 메시지를 표시합니다.로컬 디렉터리에서 이전에 다운로드된 패키지를 설치하려면 다음을 사용합니다.

# yum install /path//path/ 를 패키지 경로로 바꿉니다.

인수를 구문 분석하는 방법을 명시적으로 정의하여 패키지 검색을 최적화할 수 있습니다. 자세한 내용은 7.4.3절. “YUM 입력에서 패키지 이름 지정”를 참조하십시오.

7.4.2. YUM을 사용하여 패키지 그룹 설치

다음 절차에서는 yum 을 사용하여 그룹 이름 또는 groupID로 패키지 그룹을 설치하는 방법을 설명합니다.

절차

그룹 이름으로 패키지 그룹을 설치하려면 다음을 사용합니다.

# yum group install group-name또는

# yum install @group-namegroup-name 을 그룹 또는 환경 그룹의 전체 이름으로 바꿉니다.

groupID로 패키지 그룹을 설치하려면 다음을 사용합니다.

# yum group install groupIDgroupID 를 그룹의 ID로 바꿉니다.

7.4.3. YUM 입력에서 패키지 이름 지정

To optimize the installation and removal process, you can append-n,-na, or-nevrasuffixes toyum installandyum removecommands to explicitly define how to parse an argument:

정확한 이름을 사용하여 패키지를 설치하려면 다음을 사용합니다.

# yum install-n namename 을 정확한 패키지 이름으로 바꿉니다.

정확한 이름 및 아키텍처를 사용하여 패키지를 설치하려면 다음을 사용합니다.

# yum install-na name.architecture이름 및 아키텍처를 패키지의 정확한 이름 및 아키텍처로 바꿉니다.

정확한 이름, epoch, 버전, 릴리스 및 아키텍처를 사용하여 패키지를 설치하려면 다음을 사용합니다.

# yum install-nevra name-epoch:version-release.architecturename,epoch,version,release 및 architecture 을 정확한 이름, epoch, 버전, 릴리스 및 아키텍처로 바꿉니다.

7.5. 소프트웨어 패키지 업데이트

yum 을 사용하면 시스템에 보류 중인 업데이트가 있는지 확인할 수 있습니다. 업데이트해야 하는 패키지를 나열하고 단일 패키지, 여러 패키지 또는 모든 패키지를 한 번에 업데이트하도록 선택할 수 있습니다. 업데이트하도록 선택한 패키지에 종속성이 있는 경우 해당 패키지도 업데이트됩니다.

다음 섹션에서는 yum 을 사용하여 다음을 수행하는 방법을 설명합니다.

- 업데이트를 확인합니다.

- 단일 패키지를 업데이트합니다.

- 패키지 그룹을 업데이트합니다.

- 모든 패키지 및 해당 종속성을 업데이트합니다.

- 보안 업데이트 적용.

- 소프트웨어 업데이트 자동화.

7.5.1. YUM을 사용하여 업데이트 확인

다음 절차에서는 yum 을 사용하여 시스템에 설치된 패키지에 대해 사용 가능한 업데이트를 확인하는 방법을 설명합니다.

절차

시스템에 설치된 패키지를 확인할 수 있는 업데이트를 보려면 다음을 사용합니다.

# yum check-update출력에는 사용 가능한 업데이트가 있는 패키지 목록과 해당 종속 항목이 반환됩니다.

7.5.2. YUM을 사용하여 단일 패키지 업데이트

yum 을 사용하여 단일 패키지 및 해당 종속 항목을 업데이트하려면 다음 절차를 사용하십시오.

업데이트를 커널에 적용하는 경우 yum update 또는 yum .

install 명령을 사용하는지에 관계없이 yum 은 항상 새 커널을 설치합니다

패키지를 업데이트하려면 다음을 사용합니다.

# yum update package-namepackage-name 을 패키지 이름으로 바꿉니다.

BIOS 또는 IBM Power 시스템에서 GRUB 부트 로더 패키지를 업그레이드한 경우 GRUB을 다시 설치하십시오. GRUB 재설치를 참조하십시오.

7.5.3. YUM을 사용하여 패키지 그룹 업데이트

다음 절차에 따라 yum 을 사용하여 패키지 그룹과 해당 종속 항목을 업데이트합니다.

절차

패키지 그룹을 업데이트하려면 다음을 사용합니다.

# yum group update group-namegroup-name 을 패키지 그룹의 이름으로 바꿉니다.

BIOS 또는 IBM Power 시스템에서 GRUB 부트 로더 패키지를 업그레이드한 경우 GRUB을 다시 설치하십시오. GRUB 재설치를 참조하십시오.

7.5.4. YUM을 사용하여 모든 패키지 및 종속 항목 업데이트

다음 절차에 따라 yum 을 사용하여 모든 패키지 및 해당 종속 항목을 업데이트합니다.

절차

모든 패키지 및 해당 종속성을 업데이트하려면 다음을 사용합니다.

# yum update

BIOS 또는 IBM Power 시스템에서 GRUB 부트 로더 패키지를 업그레이드한 경우 GRUB을 다시 설치하십시오. GRUB 재설치를 참조하십시오.

7.5.5. YUM을 사용하여 보안 관련 패키지 업데이트

다음 절차에 따라 yum 을 사용하여 보안 에라타가 있는 사용 가능한 패키지를 업데이트합니다.

절차

보안 에라타가 있는 최신 패키지로 업그레이드하려면 다음을 사용합니다.

# yum update --security마지막 보안 에라타 패키지로 업그레이드하려면 다음을 사용합니다.

# yum update-minimal --security

BIOS 또는 IBM Power 시스템에서 GRUB 부트 로더 패키지를 업그레이드한 경우 GRUB을 다시 설치하십시오. GRUB 재설치를 참조하십시오.

7.5.6. 소프트웨어 업데이트 자동화

패키지 업데이트를 자동으로 및 정기적으로 확인하고 다운로드하려면 dnf-automatic 패키지에서 제공하는 DNF 자동 도구를 사용할 수 있습니다.

DNF Automatic 은 systemd 타이머, cron 작업 및 기타 해당 도구를 사용하여 자동 및 일반 실행에 적합한 대체 명령줄 인터페이스입니다.

DNF Automatic 은 필요에 따라 패키지 메타데이터를 동기화한 다음 사용 가능한 업데이트를 확인합니다. 그런 다음 도구는 구성 방법에 따라 다음 작업 중 하나를 수행할 수 있습니다.

- 종료

- 업데이트된 패키지 다운로드

- 업데이트 다운로드 및 적용

그런 다음 표준 출력 또는 이메일과 같이 선택한 메커니즘에서 작업 결과를 보고합니다.

7.5.6.1. DNF 자동 설치

다음 절차에서는 DNF 자동 툴을 설치하는 방법을 설명합니다.

절차

dnf-automatic패키지를 설치하려면 다음을 사용합니다.# yum install dnf-automatic

검증 단계

설치에 성공했는지 확인하려면 다음 명령을 실행하여

dnf-automatic패키지가 있는지 확인합니다.# rpm -qi dnf-automatic

7.5.6.2. DNF 자동 구성 파일

기본적으로 DNF 자동 에서는 /etc/dnf/automatic.conf 를 구성 파일로 사용하여 동작을 정의합니다.

구성 파일은 다음 주제 섹션으로 구분됩니다.

[명령]섹션DNF 자동 의 작동 모드를 설정합니다.

[emitters]섹션DNF 자동 의 결과를 보고하는 방법을 정의합니다.

[command_email]섹션이메일을 보내는 데 사용되는 외부 명령의 이메일 발송자 구성을 제공합니다.

[이메일]섹션전자 메일 발송자 구성을 제공합니다.

[base]섹션yum의 기본 구성 파일의 설정을 재정의합니다.

/etc/dnf/automatic.conf 파일의 기본 설정을 사용하여 DNF 자동 검사에서 사용 가능한 업데이트를 확인하고 다운로드한 다음 결과를 표준 출력으로 보고합니다.

[commands] 섹션에서 작업 모드 설정은 dnf-automatic.timer 을 제외한 모든 타이머 장치에 대해 systemd 타이머 장치에서 사용하는 설정으로 재정의됩니다.

추가 리소스

- 특정 섹션에 대한 자세한 내용은 DNF 자동 설명서를 참조하십시오.

-

systemd 타이머 장치에 대한 자세한 내용은

man dnf-automatic도움말 페이지를 참조하십시오. -

dnf-automatic 패키지에포함된 systemd 타이머 단위 의 개요는 dnf-automatic 패키지에 포함된systemd 타이머 단위의 섹션 개요를참조하십시오.

7.5.6.3. DNF 자동 활성화

DNF 자동 을 실행하려면 항상 특정 systemd 타이머 장치를 활성화하고 시작해야 합니다. dnf-automatic 패키지에 제공된 타이머 장치 중 하나를 사용하거나 필요에 따라 고유한 타이머 장치를 작성할 수 있습니다.

다음 섹션에서는 DNF 자동 활성화 방법을 설명합니다.

사전 요구 사항

-

/etc/dnf/automatic.conf구성 파일을 수정하여 DNF 자동 동작을 지정했습니다.

DNF 자동 구성 파일에 대한 자세한 내용은 섹션 2.5.6.2, "DNF 자동 구성 파일"을 참조하십시오.

절차

필요에 맞는 systemd 타이머 장치를 선택, 활성화 및 시작합니다.

# systemctl enable --now <unit>

여기서 <unit> 은 다음 타이머 중 하나입니다.

-

dnf-automatic-download.timer -

dnf-automatic-install.timer -

dnf-automatic-notifyonly.timer dnf-automatic.timer사용 가능한 업데이트를 다운로드하려면 다음을 사용하십시오.

# systemctl enable dnf-automatic-download.timer # systemctl start dnf-automatic-download.timer

사용 가능한 업데이트를 다운로드하고 설치하려면 다음을 사용합니다.

# systemctl enable dnf-automatic-install.timer # systemctl start dnf-automatic-install.timer

사용 가능한 업데이트에 대해 보고 하려면 다음을 사용합니다.

# systemctl enable dnf-automatic-notifyonly.timer # systemctl start dnf-automatic-notifyonly.timer

선택적으로 다음을 사용할 수 있습니다.

# systemctl enable dnf-automatic.timer # systemctl start dnf-automatic.timer

업데이트를 다운로드하고 적용하는 측면에서 본 타이머 장치는 /etc/dnf/automatic.conf 구성 파일의 설정에 따라 작동합니다. 기본 동작은 dnf-automatic-download.timer: 업데이트된 패키지를 다운로드하지만 설치하지는 않습니다.

또는 명령줄 또는 사용자 지정 스크립트에서 직접 /usr/bin/dnf-automatic 파일을 실행하여 DNF 자동 을 실행할 수도 있습니다.

검증 단계

타이머가 활성화되었는지 확인하려면 다음 명령을 실행합니다.

# systemctl status <systemd timer unit>

추가 리소스

-

dnf-automatic 타이머에 대한 자세한 내용은

man dnf-automatic매뉴얼 페이지를 참조하십시오. -

dnf-automatic 패키지에 포함된 systemd 타이머 장치의 개요는

dnf-automatic패키지에 포함된 systemd 타이머 단위의 섹션 개요를참조하십시오.

7.5.6.4. dnf-automatic 패키지에 포함된 systemd 타이머 단위 개요

systemd 타이머 단위는 업데이트를 다운로드하고 적용하는 데 관한 /etc/dnf/automatic.conf 구성 파일의 설정을 우선하고 재정의합니다.

예를 들어 /etc/dnf/automatic.conf 구성 파일에서 다음 옵션을 설정했지만 dnf-automatic-notifyonly.timer 장치를 활성화한 경우 패키지는 다운로드되지 않습니다.

download_updates = yes

dnf-automatic 패키지에는 다음과 같은 systemd 타이머 장치가 포함되어 있습니다.

| 타이머 단위 | 함수 | /etc/dnf/automatic.conf 파일의 설정을 재정의합니까? |

|---|---|---|

|

| 캐시할 패키지를 다운로드하고 업데이트할 수 있도록 합니다.

참고: 이 타이머 장치는 업데이트된 패키지를 설치하지 않습니다. 설치를 수행하려면 | 있음 |

|

| 업데이트된 패키지를 다운로드하고 설치합니다. | 있음 |

|

| 리포지토리 데이터만 다운로드하여 리포지토리 캐시를 최신 상태로 유지하고 사용 가능한 업데이트에 대해 알립니다. 참고: 이 타이머 장치는 업데이트된 패키지를 다운로드하거나 설치하지 않습니다 | 있음 |

|

|

업데이트를 다운로드하고 적용하기 위한 이 타이머의 동작은

기본 동작은 | 없음 |

추가 리소스

-

dnf-automatic타이머에 대한 자세한 내용은man dnf-automatic매뉴얼 페이지를 참조하십시오. -

/etc/dnf/automatic.conf구성 파일에 대한 자세한 내용은 섹션 DNF 자동 구성 파일을참조하십시오.

7.6. 소프트웨어 패키지 제거

다음 섹션에서는 yum 을 사용하여 다음을 수행하는 방법을 설명합니다.

- 패키지 제거.

- 패키지 그룹을 제거합니다.

- yum 입력으로 패키지 이름을 지정합니다.

7.6.1. YUM을 사용하여 패키지 제거

다음 절차에 따라 그룹 이름 또는 groupID로 패키지를 제거합니다.

절차

특정 패키지 및 모든 종속 패키지를 제거하려면 다음을 사용합니다.

# yum remove package-namepackage-name 을 패키지 이름으로 바꿉니다.

여러 패키지와 해당 종속 항목을 동시에 제거하려면 다음을 사용합니다.

# yum remove package-name-1 package-name-2package-name-1 및 package-name-2 를 패키지 이름으로 바꿉니다.

yum 은 패키지를 제거하지 않고 패키지를 제거할 수 없습니다.

인수를 구문 분석하는 방법을 명시적으로 정의하여 패키지 검색을 최적화할 수 있습니다. 자세한 내용은 yum input에서 패키지 이름 지정을 참조하십시오.

7.6.2. YUM을 사용하여 패키지 그룹 제거

다음 절차에 따라 그룹 이름 또는 groupID로 패키지를 제거합니다.

절차

그룹 이름으로 패키지 그룹을 제거하려면 다음을 사용합니다.

# yum group remove group-name또는

# yum remove @group-namegroup-name 을 그룹의 전체 이름으로 바꿉니다.

groupID로 패키지 그룹을 제거하려면 다음을 사용합니다.

# yum group remove groupIDgroupID 를 그룹의 ID로 바꿉니다.

7.6.3. YUM 입력에서 패키지 이름 지정

To optimize the installation and removal process, you can append-n,-na, or-nevrasuffixes toyum installandyum removecommands to explicitly define how to parse an argument:

정확한 이름을 사용하여 패키지를 설치하려면 다음을 사용합니다.

# yum install-n namename 을 정확한 패키지 이름으로 바꿉니다.

정확한 이름 및 아키텍처를 사용하여 패키지를 설치하려면 다음을 사용합니다.

# yum install-na name.architecture이름 및 아키텍처를 패키지의 정확한 이름 및 아키텍처로 바꿉니다.

정확한 이름, epoch, 버전, 릴리스 및 아키텍처를 사용하여 패키지를 설치하려면 다음을 사용합니다.

# yum install-nevra name-epoch:version-release.architecturename,epoch,version,release 및 architecture 을 정확한 이름, epoch, 버전, 릴리스 및 아키텍처로 바꿉니다.

7.7. 소프트웨어 패키지 그룹 관리

패키지 그룹은 공통 목적을 제공하는 패키지 컬렉션입니다(시스템 도구, 사운드 및 비디오). 패키지 그룹을 설치하면 종속 패키지 집합이 가져와 시간을 크게 절약할 수 있습니다.

다음 섹션에서는 yum 을 사용하여 다음을 수행하는 방법을 설명합니다.

- 패키지 그룹 나열.

- 패키지 그룹을 설치합니다.

- 패키지 그룹을 제거합니다.

- yum 입력에서 전역 표현식을 지정합니다.

7.7.1. YUM을 사용하여 패키지 그룹 나열

yum 을 사용하여 설치된 패키지 그룹을 보고 목록 결과를 필터링합니다.

절차

설치되어 사용 가능한 그룹 수를 보려면 다음을 사용합니다.

# yum group summary설치되어 사용 가능한 그룹을 모두 나열하려면 다음을 사용합니다.

# yum group listyum group list명령(--hidden, --available)에 대한 명령줄 옵션을 추가하여 결과를 필터링할 수 있습니다. 사용 가능한 옵션은 도움말 페이지를 참조하십시오.특정 그룹에 포함된 필수 및 선택적 패키지를 나열하려면 다음을 사용합니다.

# yum group info group-namegroup-name 을 그룹 이름으로 바꿉니다.

글로벌 표현식을 인수로 추가하여 결과를 필터링할 수 있습니다. yum 입력에서 글로벌 표현식 지정참조

자세한 내용은.

7.7.2. YUM을 사용하여 패키지 그룹 설치

다음 절차에서는 yum 을 사용하여 그룹 이름 또는 groupID로 패키지 그룹을 설치하는 방법을 설명합니다.

절차

그룹 이름으로 패키지 그룹을 설치하려면 다음을 사용합니다.

# yum group install group-name또는

# yum install @group-namegroup-name 을 그룹 또는 환경 그룹의 전체 이름으로 바꿉니다.

groupID로 패키지 그룹을 설치하려면 다음을 사용합니다.

# yum group install groupIDgroupID 를 그룹의 ID로 바꿉니다.

7.7.3. YUM을 사용하여 패키지 그룹 제거

다음 절차에 따라 그룹 이름 또는 groupID로 패키지를 제거합니다.

절차

그룹 이름으로 패키지 그룹을 제거하려면 다음을 사용합니다.

# yum group remove group-name또는

# yum remove @group-namegroup-name 을 그룹의 전체 이름으로 바꿉니다.

groupID로 패키지 그룹을 제거하려면 다음을 사용합니다.

# yum group remove groupIDgroupID 를 그룹의 ID로 바꿉니다.

7.7.4. YUM 입력에서 글로벌 표현식 지정

yum 명령을 사용하면 하나 이상의 glob 표현식 을 인수로 추가하여 결과를 필터링할 수 있습니다. 전역 표현식을 yum 명령에 인수로 전달할 때 이스케이프해야 합니다.

절차

To ensure global expressions are passed to yum as intended, use one of the following methods:

전체 글로벌 표현식을 큰따옴표 또는 단일 따옴표로 묶습니다.

# yum provides "*/file-name"file-name 을 파일 이름으로 바꿉니다.

와일드카드 문자를 백슬래시(\)

문자로이스케이프합니다.# yum provides \*/file-namefile-name 을 파일 이름으로 바꿉니다.

7.8. 패키지 관리 내역 처리

yum history 명령을 사용하면 yum 트랜잭션의 타임라인, 발생한 날짜 및 시간, 영향을 받는 패키지 수, 이러한 트랜잭션의 성공 또는 중단 여부, 트랜잭션 간에 RPM 데이터베이스 변경에 대한 정보를 검토할 수 있습니다. 또한 yum history 명령을 사용하여 트랜잭션을 실행 취소하거나 다시 실행할 수 있습니다.

다음 섹션에서는 yum 을 사용하여 다음을 수행하는 방법을 설명합니다.

- 트랜잭션 나열.

- 트랜잭션 되돌리기.

- 트랜잭션 반복.

- yum 입력에서 전역 표현식을 지정합니다.

7.8.1. YUM을 사용하여 트랜잭션 나열

다음 절차에 따라 최신 트랜잭션, 선택한 패키지에 대한 최신 작업 및 특정 트랜잭션의 세부 정보를 나열합니다.

절차

최신 yum 트랜잭션 목록을 표시하려면 다음을 사용합니다.

# yum history선택한 패키지에 대한 모든 최신 작업 목록을 표시하려면 다음을 사용합니다.

# yum history list package-namepackage-name 을 패키지 이름으로 바꿉니다. 전역 표현식을 추가하여 명령 출력을 필터링할 수 있습니다. 자세한 내용은 yum 입력에서 전역 표현식 지정을 참조하십시오.

특정 트랜잭션을 검사하려면 다음을 사용합니다.

# yum history info transactionIDtransactionID 를 트랜잭션의 ID로 바꿉니다.

7.8.2. YUM을 사용하여 트랜잭션 복원

다음 절차에서는 yum 을 사용하여 선택한 트랜잭션 또는 마지막 트랜잭션을 되돌리는 방법을 설명합니다.

절차

특정 트랜잭션을 되돌리려면 다음을 사용합니다.

# yum history undo transactionIDtransactionID 를 트랜잭션의 ID로 바꿉니다.

마지막 트랜잭션을 되돌리려면 다음을 사용합니다.

# yum history undo last

yum history undo 명령은 트랜잭션 중에 수행된 단계만 되돌립니다. 트랜잭션이 새 패키지를 설치한 경우 yum history undo 명령은 이를 제거합니다. 트랜잭션에서 패키지를 제거한 경우 yum history undo 명령으로 다시 설치합니다. yum history는 이전 패키지를 사용할 수 있는 경우 업데이트된 모든 패키지를 이전 버전으로 다운그레이드하려고 시도합니다.

7.8.3. YUM을 사용하여 트랜잭션 반복

다음 절차에 따라 yum 을 사용하여 선택한 트랜잭션 또는 마지막 트랜잭션을 반복합니다.

절차

특정 트랜잭션을 반복하려면 다음을 사용합니다.

# yum history redo transactionIDtransactionID 를 트랜잭션의 ID로 바꿉니다.

마지막 트랜잭션을 반복하려면 다음을 사용합니다.

# yum history redo last

yum history redo 명령은 트랜잭션 중에 수행된 단계만 반복합니다.

7.8.4. YUM 입력에서 글로벌 표현식 지정

yum 명령을 사용하면 하나 이상의 glob 표현식 을 인수로 추가하여 결과를 필터링할 수 있습니다. 전역 표현식을 yum 명령에 인수로 전달할 때 이스케이프해야 합니다.

절차

To ensure global expressions are passed to yum as intended, use one of the following methods:

전체 글로벌 표현식을 큰따옴표 또는 단일 따옴표로 묶습니다.

# yum provides "*/file-name"file-name 을 파일 이름으로 바꿉니다.

와일드카드 문자를 백슬래시(\)

문자로이스케이프합니다.# yum provides \*/file-namefile-name 을 파일 이름으로 바꿉니다.

7.9. 소프트웨어 리포지토리 관리

yum 및 관련 유틸리티의 구성 정보는 /etc/yum.conf 파일에 저장됩니다. 이 파일에는 리포지토리별 옵션을 설정할 수 있는 하나 이상의 [repository] 섹션이 포함되어 있습니다.

/etc/yum.repos 파일에 개별 리포지토리를 정의하는 것이 좋습니다.

.d/ 디렉터리에 새 또는 기존.repo

/etc/yum.conf 파일의 개별 [repository] 섹션에 정의된 값은 [main] 섹션에 설정된 값을 재정의합니다.

다음 섹션에서는 다음을 수행하는 방법을 설명합니다.

-

[repository]옵션을 설정합니다. - yum 리포지토리를 추가합니다.

- yum 리포지토리를 활성화합니다.

- yum 리포지토리를 비활성화합니다.

7.9.1. YUM 리포지토리 옵션 설정

/etc/yum.conf 구성 파일에는 [repository] 섹션이 포함되어 있습니다. 여기서 리포지토리 는 고유한 리포지토리 ID입니다. [repository] 섹션을 통해 개별 yum 리포지토리를 정의할 수 있습니다.

충돌을 피하기 위해 Red Hat 리포지토리에서 사용하는 사용자 정의 리포지토리 이름을 지정하지 마십시오.

사용 가능한 [repository] 옵션의 전체 목록은 yum.conf(5) 도움말 페이지의 [repository] OPTIONS 섹션을 참조하십시오.

7.9.2. YUM 리포지토리 추가

절차

새 리포지토리를 정의하려면 다음을 수행할 수 있습니다.

-

[repository]섹션을/etc/yum.conf파일에 추가합니다. [repository]섹션을/etc/yum파일에 추가합니다..repos.d/ 디렉터리의.repoYum 리포지토리는 일반적으로 고유한

.repo파일을 제공합니다.

/etc/yum.conf 대신 .repo 파일에 있는 리포지토리를 이 디렉토리의. repo 파일 확장자가 있는 모든 파일은 yum 으로 정의하는 것이 좋습니다.

시스템에 리포지터리를 추가하고 활성화하려면 다음을 사용합니다.

# yum-config-manager --add-repo repository_URLrepository_url 을 리포지토리를 가리키는 URL로 바꿉니다.

Red Hat Certificate-basedCDN( Content Delivery Network ) 이외의 검증 또는 신뢰할 수 없는 소스에서 소프트웨어 패키지를 구입하고 설치하면 잠재적인 보안 위험이 되며 보안, 안정성, 호환성 및 유지 관리 문제로 이어질 수 있습니다.

7.9.3. YUM 리포지토리 활성화

yum 리포지토리를 시스템에 추가한 후 이를 활성화하여 설치 및 업데이트를 확인합니다.

절차

리포지터리를 활성화하려면 다음을 사용합니다.

# yum-config-manager --enable repositoryIDrepositoryID를 고유한 리포지토리 ID로 바꿉니다.

사용 가능한 리포지토리 ID를 나열하려면 yum을 사용하여 패키지 나열 을 참조하십시오.

7.9.4. YUM 리포지토리 비활성화

특정 YUM 리포지토리를 비활성화하여 특정 패키지가 설치 또는 업데이트되지 않도록 합니다.

절차

yum 리포지토리를 비활성화하려면 다음을 사용합니다.

# yum-config-manager --disable repositoryIDrepositoryID를 고유한 리포지토리 ID로 바꿉니다.

사용 가능한 리포지토리 ID를 나열하려면 yum을 사용하여 패키지 나열 을 참조하십시오.

7.10. YUM 구성

yum 및 관련 유틸리티의 구성 정보는 /etc/yum.conf 파일에 저장됩니다. 이 파일에는 필수 [main] 섹션 하나가 포함되어 있어 글로벌 효과가 있는 yum 옵션을 설정할 수 있습니다.

다음 섹션에서는 다음을 수행하는 방법을 설명합니다.

- 현재 yum 구성을 봅니다.

- yum [main] 옵션을 설정합니다.

- yum 플러그인 사용.

7.10.1. 현재 YUM 구성 보기

현재 yum 구성을 보려면 다음 절차를 사용하십시오.

절차

/etc/파일의yum.conf[main]섹션에 지정된 글로벌 yum 옵션의 현재 값을 표시하려면 다음을 사용합니다.# yum config-manager --dump

7.10.2. YUM 기본 옵션 설정

/etc/yum.conf 구성 파일에는 [main] 섹션 하나가 포함되어 있습니다. 아래에 나열된 키-값 쌍은 yum 이 리포지토리를 작동하고 처리하는 방식에 영향을 미칩니다.

/etc/yum.conf 의 [main] 섹션 제목 아래에 추가 옵션을 추가할 수 있습니다.

사용 가능한 [main] 옵션의 전체 목록은 yum.conf(5) 도움말 페이지의 [main] OPTIONS 섹션을 참조하십시오.

7.10.3. YUM 플러그인 사용

yum 은 운영을 확장하고 개선하는 플러그인을 제공합니다. 특정 플러그인은 기본적으로 설치됩니다.

다음 섹션에서는 yum 플러그인을 활성화, 구성 및 비활성화하는 방법을 설명합니다.

7.10.3.1. YUM 플러그인 관리

절차

플러그인 구성 파일에는 항상 yum 명령을 실행할 때 플러그인이 활성화되는 지 여부를 제어하는 [main] 섹션이 있습니다. 이 옵션이 없는 경우 파일에 수동으로 추가할 수 있습니다.

설치된 모든 플러그인에는 /etc/dnf/plugins/ 디렉터리에 자체 구성 파일이 있습니다. 이러한 파일에서 플러그인별 옵션을 활성화하거나 비활성화할 수 있습니다.

7.10.3.2. YUM 플러그인 활성화

다음 절차에서는 모든 YUM 플러그인을 비활성화하거나 활성화하거나 특정 명령의 모든 플러그인을 비활성화하거나 단일 명령의 특정 YUM 플러그인을 비활성화하는 방법을 설명합니다.

절차

모든 yum 플러그인을 활성화하려면 다음을 수행합니다.

-

plugins=로 시작하는 행이/etc/yum.conf파일의[main]섹션에 있는지 확인합니다. plugins=의 값을1로 설정합니다.plugins=1

-

7.10.3.3. YUM 플러그인 비활성화

모든 yum 플러그인을 비활성화하려면 다음을 수행합니다.

-

plugins=로 시작하는 행이/etc/yum.conf파일의[main]섹션에 있는지 확인합니다. plugins=의 값을0으로 설정합니다.plugins=0

중요모든 플러그인을 비활성화하는 것은 바람직하지 않습니다. 특정 플러그인은 중요한 yum 서비스를 제공합니다. 특히 product-id 및 subscription -manager 플러그인은 인증서 기반CDN(

Content Delivery Network)에 대한 지원을 제공합니다. 플러그인을 전역적으로 비활성화하는 것은 편의성 옵션으로 제공되며 yum 에서 잠재적인 문제를 진단할 때만 권장됩니다.

-

특정 명령에 대해 모든 yum 플러그인을 비활성화하려면 명령에

--noplugins옵션을 추가합니다.# yum --noplugins update단일 명령에 특정 yum 플러그인을 비활성화하려면 명령에

--disableplugin=plugin-name옵션을 추가합니다.# yum update --disableplugin=plugin-nameplugin-name 을 플러그인 이름으로 바꿉니다.

8장. RHEL 시스템 역할 소개

RHEL 시스템 역할을 사용하여 여러 시스템에서 시스템 관리를 자동화할 수 있습니다.

RHEL 시스템 역할은 Ansible 역할 및 모듈의 컬렉션입니다. RHEL 시스템 역할을 사용하면 RHEL의 주요 버전에서 여러 RHEL 시스템의 시스템 구성을 원격으로 관리할 수 있습니다. 시스템을 구성하는 데 사용하려면 다음 구성 요소를 사용해야 합니다.

- 제어 노드

- 제어 노드는 Ansible 명령 및 플레이북을 실행하는 시스템입니다. 제어 노드는 Ansible Automation Platform, Red Hat Satellite 또는 RHEL 9, 8 또는 7 호스트일 수 있습니다. 자세한 내용은 RHEL 8에서 제어 노드 준비를 참조하십시오.

- 관리형 노드

- 관리형 노드는 Ansible로 관리하는 서버 및 네트워크 장치입니다. 관리 노드를 호스트라고도 합니다. Ansible을 관리형 노드에 설치할 필요가 없습니다. 자세한 내용은 관리 노드 준비를 참조하십시오.

- Ansible 플레이북

- 플레이북에서는 관리형 노드에서 수행할 구성을 정의하거나 수행할 관리 노드의 시스템의 단계 집합을 정의합니다. 플레이북은 Ansible의 구성, 배포 및 오케스트레이션 언어입니다.

- 인벤토리

- 인벤토리 파일에서 관리 노드를 나열하고 각 관리 노드의 IP 주소와 같은 정보를 지정합니다. 인벤토리에서는 더 쉽게 스케일링할 수 있도록 그룹을 생성하고 중첩하여 관리 노드를 구성할 수도 있습니다. 인벤토리 파일을 호스트 파일이라고도 합니다.

Red Hat Enterprise Linux 8에서는 AppStream 리포지토리에서 사용할 수 있는 rhel-system-roles 패키지에서 제공하는 다음 역할을 사용할 수 있습니다.

| 역할 이름 | 역할 설명 | 장 제목 |

|---|---|---|

|

| 인증서 발행 및 갱신 | RHEL 시스템 역할을 사용하여 인증서 요청 |

|

| 웹 콘솔 | cockpit RHEL 시스템 역할을 사용하여 웹 콘솔 설치 및 구성 |

|

| 시스템 전체 암호화 정책 | 시스템 전체에서 사용자 정의 암호화 정책 설정 |

|

| firewalld | 시스템 역할을 사용하여 firewalld 구성 |

|

| HA 클러스터 | 시스템 역할을 사용하여 고가용성 클러스터 구성 |

|

| 커널 덤프 | RHEL 시스템 역할을 사용하여 kdump 구성 |

|

| 커널 설정 | Ansible 역할을 사용하여 커널 매개변수를 영구적으로 구성 |

|

| 로깅 | 로깅 시스템 역할 사용 |

|

| 메트릭 (PCP) | RHEL 시스템 역할을 사용하여 성능 모니터링 |

|

| Microsoft SQL Server | Cryostat.sql.server Ansible 역할을 사용하여 Microsoft SQL Server 구성 |

|

| 네트워킹 | 네트워크 RHEL 시스템 역할을 사용하여 InfiniBand 연결 관리 |

|

| 네트워크 Bound 디스크 암호화 클라이언트 | nbde_client 및 nbde_server 시스템 역할 사용 |

|

| 네트워크 Bound 디스크 암호화 서버 | nbde_client 및 nbde_server 시스템 역할 사용 |

|

| Postfix | 시스템 역할에서 postfix 역할의 변수 |

|

| PostgreSQL | postgresql RHEL 시스템 역할을 사용하여 PostgreSQL 설치 및 구성 |

|

| SELinux | 시스템 역할을 사용하여 SELinux 구성 |

|

| SSH 클라이언트 | ssh 시스템 역할과 보안 통신 구성 |

|

| SSH 서버 | ssh 시스템 역할과 보안 통신 구성 |

|

| 스토리지 | RHEL 시스템 역할을 사용하여 로컬 스토리지 관리 |

|

| 터미널 세션 레코딩 | tlog RHEL 시스템 역할을 사용하여 세션 레코딩 시스템 구성 |

|

| 시간 동기화 | RHEL 시스템 역할을 사용하여 시간 동기화 구성 |

|

| VPN | vpn RHEL 시스템 역할을 사용하여 IPsec으로 VPN 연결 구성 |

추가 리소스

- RHEL 시스템 역할을 사용하여 시스템 관리 자동화

- RHEL(Red Hat Enterprise Linux) 시스템 역할

-

/usr/share/ansible/roles/rhel-system-roles. <role_name> /README.md파일 -

/usr/share/doc/rhel-system-roles/<role_name>/directory

9장. 로깅 구성

Red Hat Enterprise Linux의 대부분의 서비스는 상태 메시지, 경고 및 오류를 기록합니다. rsyslogd 서비스를 사용하여 이러한 항목을 로컬 파일 또는 원격 로깅 서버에 기록할 수 있습니다.

9.1. 원격 로깅 솔루션 구성

환경에서 다양한 시스템의 로그가 로깅 서버에 중앙에 기록되도록 하기 위해 클라이언트 시스템에서 서버에 대한 특정 기준에 맞는 로그를 기록하도록 Rsyslog 애플리케이션을 구성할 수 있습니다.

9.1.1. Rsyslog 로깅 서비스

systemd-journald 서비스와 함께 Rsyslog 애플리케이션은 Red Hat Enterprise Linux에서 로컬 및 원격 로깅 지원을 제공합니다. rsyslogd 데몬은 journal에서 systemd-journald 서비스에서 수신한 syslog 메시지를 지속적으로 읽습니다. rsyslogd 는 이러한 syslog 이벤트를 필터링 및 처리하고 rsyslog 로그 파일에 기록하거나 구성에 따라 다른 서비스에 전달합니다.

rsyslogd 데몬은 또한 확장된 필터링, 메시지의 암호화 보호 릴레이, 입력 및 출력 모듈, TCP 및 UDP 프로토콜을 사용하여 운송을 지원합니다.

rsyslog의 기본 구성 파일인 /etc/rsyslog.conf 에서 메시지를 처리하는 rsyslog d 에 따라 규칙을 지정할 수 있습니다. 일반적으로 소스 및 주제(유효성) 및 긴급성(우선 순위)에 따라 메시지를 분류한 다음, 메시지가 이러한 기준에 맞는 경우 수행해야 하는 작업을 할당할 수 있습니다.

/etc/rsyslog.conf 에서 rsyslogd 가 유지 관리하는 로그 파일 목록을 볼 수도 있습니다. 대부분의 로그 파일은 /var/log/ 디렉토리에 있습니다. httpd 및 samba 와 같은 일부 애플리케이션은 /var/log/ 내의 하위 디렉터리에 로그 파일을 저장합니다.

추가 리소스

-

rsyslogd(8)및rsyslog.conf(5)도움말 페이지. -

/usr/share/doc/rsyslog/html/index.html파일의rsyslog-doc패키지와 함께 설치된 설명서입니다.

9.1.2. Rsyslog 문서 설치

Rsyslog 애플리케이션에는 https://www.rsyslog.com/doc/ 에서 제공되는 광범위한 온라인 문서가 있지만, rsyslog-doc 설명서 패키지를 로컬로 설치할 수도 있습니다.

사전 요구 사항

-

시스템에서

AppStream리포지토리를 활성화했습니다. -

sudo를 사용하여 새 패키지를 설치할 권한이 있습니다.

절차

rsyslog-doc패키지를 설치합니다.# yum install rsyslog-doc

검증

선택한 브라우저에서

/usr/share/doc/rsyslog/html/index.html파일을 엽니다. 예를 들면 다음과 같습니다.$ firefox /usr/share/doc/rsyslog/html/index.html &

9.1.3. TCP를 통한 원격 로깅을 위한 서버 구성

Rsyslog 애플리케이션을 사용하면 로깅 서버를 실행하고 로그 파일을 로깅 서버로 보내도록 개별 시스템을 구성할 수 있습니다. TCP를 통해 원격 로깅을 사용하려면 서버와 클라이언트를 둘 다 구성합니다. 서버는 하나 이상의 클라이언트 시스템에서 전송한 로그를 수집하고 분석합니다.

Rsyslog 애플리케이션을 사용하면 로그 메시지가 네트워크를 통해 서버로 전달되는 중앙 집중식 로깅 시스템을 유지 관리할 수 있습니다. 서버를 사용할 수 없는 경우 메시지 손실을 방지하기 위해 전달 작업에 대한 작업 대기열을 구성할 수 있습니다. 이렇게 하면 전송에 실패한 메시지는 서버에 다시 연결할 때까지 로컬에 저장됩니다. 이러한 큐는 UDP 프로토콜을 사용하여 연결에 대해 구성할 수 없습니다.

omfwd 플러그인은 UDP 또는 TCP를 통해 전달을 제공합니다. 기본 프로토콜은 UDP입니다. 플러그인이 빌드되었으므로 로드할 필요가 없습니다.

기본적으로 rsyslog 는 포트 514 에서 TCP를 사용합니다.

사전 요구 사항

- rsyslog가 서버 시스템에 설치되어 있습니다.

-

서버에서

root로 로그인했습니다. -

semanage명령을 사용하여 선택적 단계를 위해policycoreutils-python-utils패키지가 설치됩니다. -

firewalld서비스가 실행 중입니다.

절차

선택 사항:

rsyslog트래픽에 다른 포트를 사용하려면syslogd_port_tSELinux 유형을 포트에 추가합니다. 예를 들어 포트30514를 활성화합니다.# semanage port -a -t syslogd_port_t -p tcp 30514선택 사항:

rsyslog트래픽에 다른 포트를 사용하려면 해당 포트에서 들어오는rsyslog트래픽을 허용하도록firewalld를 구성합니다. 예를 들어 포트30514에서 TCP 트래픽을 허용합니다.# firewall-cmd --zone=<zone-name> --permanent --add-port=30514/tcp success # firewall-cmd --reload

/etc/rsyslog.d/디렉토리(예:remotelog.conf)에 새 파일을 생성하고 다음 내용을 삽입합니다.# Define templates before the rules that use them # Per-Host templates for remote systems template(name="TmplAuthpriv" type="list") { constant(value="/var/log/remote/auth/") property(name="hostname") constant(value="/") property(name="programname" SecurePath="replace") constant(value=".log") } template(name="TmplMsg" type="list") { constant(value="/var/log/remote/msg/") property(name="hostname") constant(value="/") property(name="programname" SecurePath="replace") constant(value=".log") } # Provides TCP syslog reception module(load="imtcp") # Adding this ruleset to process remote messages ruleset(name="remote1"){ authpriv.* action(type="omfile" DynaFile="TmplAuthpriv") *.info;mail.none;authpriv.none;cron.none action(type="omfile" DynaFile="TmplMsg") } input(type="imtcp" port="30514" ruleset="remote1")-

/etc/rsyslog.d/remotelog.conf파일에 변경 사항을 저장합니다. /etc/rsyslog.conf 파일의 구문을 테스트합니다.# rsyslogd -N 1 rsyslogd: version 8.1911.0-2.el8, config validation run... rsyslogd: End of config validation run. Bye.로깅 서버에서

rsyslog서비스가 실행 중이고 활성화되어 있는지 확인합니다.# systemctl status rsyslogrsyslog서비스를 다시 시작합니다.# systemctl restart rsyslog선택 사항:

rsyslog가 활성화되지 않은 경우 재부팅 후rsyslog서비스가 자동으로 시작되는지 확인하십시오.# systemctl enable rsyslog

이제 로그 서버가 환경의 다른 시스템에서 로그 파일을 수신하고 저장하도록 구성되어 있습니다.

추가 리소스

-

rsyslogd(8),rsyslog.conf(5),semanage(8)및firewall-cmd(1)도움말 페이지. -

/usr/share/doc/rsyslog/html/index.html파일의rsyslog-doc패키지와 함께 설치된 설명서입니다.

9.1.4. TCP를 통해 서버에 원격 로깅 구성

다음 절차에 따라 TCP 프로토콜을 통해 로그 메시지를 서버로 전달하기 위한 시스템을 구성합니다. omfwd 플러그인은 UDP 또는 TCP를 통해 전달을 제공합니다. 기본 프로토콜은 UDP입니다. 플러그인이 빌드되었으므로 로드할 필요가 없습니다.

사전 요구 사항

-

rsyslog패키지는 서버에 보고해야 하는 클라이언트 시스템에 설치됩니다. - 원격 로깅을 위해 서버를 구성했습니다.

- 지정된 포트는 SELinux에서 허용되며 방화벽에서 열립니다.

-

시스템에는 SELinux 구성에 비표준 포트를 추가하기 위한

semanage명령을 제공하는policycoreutils-python-utils패키지가 포함되어 있습니다.

절차

/etc/rsyslog.d/디렉토리에 라는 새 파일을 만듭니다(예:10-remotelog.conf).*.* action(type="omfwd" queue.type="linkedlist" queue.filename="example_fwd" action.resumeRetryCount="-1" queue.saveOnShutdown="on" target="example.com" port="30514" protocol="tcp" )다음과 같습니다.

-

queue.type="linkedlist"설정은 LinkedList in-memory 큐를 활성화합니다. -

queue.filename설정은 디스크 스토리지를 정의합니다. 백업 파일은 이전 globalworkDirectory지시문에서 지정한 작업 디렉터리에example_fwd접두사를 사용하여 생성됩니다. -

action.resumeRetryCount -1설정은 서버가 응답하지 않는 경우 연결을 다시 시도할 때rsyslog가 메시지를 삭제하지 않도록 합니다. -

rsyslog가 종료되면queue.saveOnShutdown="on"설정은 메모리 내 데이터를 저장합니다. 마지막 줄은 수신된 모든 메시지를 로깅 서버로 전달합니다. 포트 사양은 선택 사항입니다.

이 구성을 사용하면

rsyslog에서 서버로 메시지를 전송하지만 원격 서버에 연결할 수 없는 경우 메시지를 메모리에 유지합니다. 디스크의 파일은rsyslog가 구성된 메모리 대기열 공간에서 부족하거나 시스템 성능을 향상시킬 수 있는 를 종료해야 하는 경우에만 생성됩니다.

참고rsyslog는 사전 순서로 구성 파일

/etc/rsyslog.d/를 처리합니다.-

rsyslog서비스를 다시 시작합니다.# systemctl restart rsyslog

검증

클라이언트 시스템이 서버에 메시지를 전송하는지 확인하려면 다음 단계를 따르십시오.

클라이언트 시스템에서 테스트 메시지를 전송합니다.

# logger test서버 시스템에서

/var/log/messages로그를 확인합니다. 예를 들면 다음과 같습니다.# cat /var/log/remote/msg/hostname/root.log Feb 25 03:53:17 hostname root[6064]: test

여기서 hostname 은 클라이언트 시스템의 호스트 이름입니다. 로그에는

로거명령을 입력한 사용자의 사용자 이름이 포함됩니다(이 경우root).

추가 리소스

-

rsyslogd(8)및rsyslog.conf(5)도움말 페이지. -

/usr/share/doc/rsyslog/html/index.html파일의rsyslog-doc패키지와 함께 설치된 설명서입니다.

9.1.5. TLS 암호화 원격 로깅 구성

기본적으로 Rsyslog는 일반 텍스트 형식으로 원격 블로그 통신을 보냅니다. 시나리오에 이 통신 채널을 보호해야 하는 경우 TLS를 사용하여 암호화할 수 있습니다.

TLS를 통해 암호화된 전송을 사용하려면 서버와 클라이언트 모두를 구성합니다. 서버는 하나 이상의 클라이언트 시스템에서 전송한 로그를 수집하고 분석합니다.

ossl 네트워크 스트림 드라이버(OpenSSL) 또는 gtls 스트림 드라이버(GnuTLS)를 사용할 수 있습니다.

더 높은 보안이 있는 별도의 시스템이 있는 경우(예: 네트워크에 연결되지 않거나 엄격한 권한이 있는 시스템)를 인증 기관(CA)으로 별도의 시스템을 사용하십시오.

사전 요구 사항

-

클라이언트와 서버 시스템에 모두

root액세스 권한이 있습니다. -

rsyslog및rsyslog-openssl패키지가 서버 및 클라이언트 시스템에 설치됩니다. -

gtls네트워크 스트림 드라이버를 사용하는 경우rsyslog-openssl대신rsyslog-gnutls패키지를 설치합니다. -

certtool명령을 사용하여 인증서를 생성하는 경우gnutls-utils패키지를 설치합니다. 로깅 서버에서 다음 인증서는

/etc/pki/ca-trust/source/anchors/디렉터리에 있으며update-ca-trust명령을 사용하여 시스템 구성을 업데이트합니다.-

ca-cert.pem- 로깅 서버 및 클라이언트의 키와 인증서를 확인할 수 있는 CA 인증서입니다. -

server-cert.pem- 로깅 서버의 공개 키입니다. -

server-key.pem- 로깅 서버의 개인 키입니다.

-

로깅 클라이언트에서 다음 인증서는

/etc/pki/ca-trust/source/anchors/디렉터리에 있으며,update-ca-trust를 사용하여 시스템 설정을 업데이트합니다.-

ca-cert.pem- 로깅 서버 및 클라이언트의 키와 인증서를 확인할 수 있는 CA 인증서입니다. -

client-cert.pem- 클라이언트의 공개 키입니다. -

client-key.pem- 클라이언트의 개인 키입니다.

-

절차

클라이언트 시스템에서 암호화된 로그를 수신하도록 서버를 구성합니다.

-

/etc/journal.d/디렉토리에 라는 새 파일을 만듭니다(예:securelogser.conf). 통신을 암호화하려면 구성 파일에 서버의 인증서 파일 경로, 선택한 인증 방법 및 TLS 암호화를 지원하는 스트림 드라이버가 포함되어야 합니다.

/etc/octets.d/securelogser.conf 파일에 다음 행을 추가합니다.# Set certificate files global( DefaultNetstreamDriverCAFile="/etc/pki/ca-trust/source/anchors/ca-cert.pem" DefaultNetstreamDriverCertFile="/etc/pki/ca-trust/source/anchors/server-cert.pem" DefaultNetstreamDriverKeyFile="/etc/pki/ca-trust/source/anchors/server-key.pem" ) # TCP listener module( load="imtcp" PermittedPeer=["client1.example.com", "client2.example.com"] StreamDriver.AuthMode="x509/name" StreamDriver.Mode="1" StreamDriver.Name="ossl" ) # Start up listener at port 514 input( type="imtcp" port="514" )

참고GnuTLS 드라이버를 선호하는 경우

StreamDriver.Name="gtls"구성 옵션을 사용합니다.x509/name보다 엄격한 인증 모드에 대한 자세한 내용은rsyslog-doc패키지로 설치된 설명서를 참조하십시오.-

/etc/octets.d/securelogser.conf파일에 변경 사항을 저장합니다. /etc/octets.conf파일 구문 및/etc/octets.d/ 디렉토리에 있는 모든 파일을 확인합니다.# rsyslogd -N 1 rsyslogd: version 8.1911.0-2.el8, config validation run (level 1)... rsyslogd: End of config validation run. Bye.로깅 서버에서

rsyslog서비스가 실행 중이고 활성화되어 있는지 확인합니다.# systemctl status rsyslogrsyslog서비스를 다시 시작하십시오.# systemctl restart rsyslog선택 사항: Rsyslog가 활성화되지 않은 경우 재부팅 후

rsyslog서비스가 자동으로 시작됩니다.# systemctl enable rsyslog

-

암호화된 로그를 서버에 전송하도록 클라이언트를 구성합니다.

-

클라이언트 시스템에서

/etc/journal.d/디렉토리에 라는 새 파일을 만듭니다(예:securelogcli.conf). /etc/octets.d/securelogcli.conf 파일에 다음 행을 추가합니다.# Set certificate files global( DefaultNetstreamDriverCAFile="/etc/pki/ca-trust/source/anchors/ca-cert.pem" DefaultNetstreamDriverCertFile="/etc/pki/ca-trust/source/anchors/client-cert.pem" DefaultNetstreamDriverKeyFile="/etc/pki/ca-trust/source/anchors/client-key.pem" ) # Set up the action for all messages *.* action( type="omfwd" StreamDriver="ossl" StreamDriverMode="1" StreamDriverPermittedPeers="server.example.com" StreamDriverAuthMode="x509/name" target="server.example.com" port="514" protocol="tcp" )

참고GnuTLS 드라이버를 선호하는 경우

StreamDriver.Name="gtls"구성 옵션을 사용합니다.-

/etc/octets.d/securelogser.conf파일에 변경 사항을 저장합니다. /etc/rsyslog.conf파일 및 기타 파일의 구문을/etc/rsyslog.d/디렉터리에 확인합니다.# rsyslogd -N 1 rsyslogd: version 8.1911.0-2.el8, config validation run (level 1)... rsyslogd: End of config validation run. Bye.로깅 서버에서

rsyslog서비스가 실행 중이고 활성화되어 있는지 확인합니다.# systemctl status rsyslogrsyslog서비스를 다시 시작하십시오.# systemctl restart rsyslog선택 사항: Rsyslog가 활성화되지 않은 경우 재부팅 후

rsyslog서비스가 자동으로 시작됩니다.# systemctl enable rsyslog

-

클라이언트 시스템에서

검증

클라이언트 시스템이 서버에 메시지를 전송하는지 확인하려면 다음 단계를 따르십시오.

클라이언트 시스템에서 테스트 메시지를 전송합니다.

# logger test서버 시스템에서

/var/log/messages로그를 확인합니다. 예를 들면 다음과 같습니다.# cat /var/log/remote/msg/hostname/root.log Feb 25 03:53:17 hostname root[6064]: test

여기서

hostname은 클라이언트 시스템의 호스트 이름입니다. 로그에는 로거 명령을 입력한 사용자의 사용자 이름이 포함됩니다(이 경우root).

추가 리소스

-

certtool(1),openssl(1),update-ca-trust(8),rsyslogd(8),rsyslog.conf(5)매뉴얼 페이지. -

/usr/share/doc/rsyslog/html/index.html의rsyslog-doc패키지와 함께 설치된 설명서입니다. - TLS에서 로깅 시스템 역할 사용.

9.1.6. UDP를 통해 원격 로깅 정보를 받기 위한 서버 설정

Rsyslog 애플리케이션을 사용하면 원격 시스템에서 로깅 정보를 수신하도록 시스템을 구성할 수 있습니다. UDP를 통해 원격 로깅을 사용하려면 서버와 클라이언트를 둘 다 구성합니다. 수신 서버는 하나 이상의 클라이언트 시스템에서 전송한 로그를 수집하고 분석합니다. 기본적으로 rsyslog 는 포트 514 에서 UDP를 사용하여 원격 시스템에서 로그 정보를 받습니다.

다음 절차에 따라 UDP 프로토콜을 통해 하나 이상의 클라이언트 시스템에서 전송한 로그를 수집하고 분석하기 위해 서버를 구성합니다.

사전 요구 사항

- rsyslog가 서버 시스템에 설치되어 있습니다.

-

서버에서

root로 로그인했습니다. -

semanage명령을 사용하여 선택적 단계를 위해policycoreutils-python-utils패키지가 설치됩니다. -

firewalld서비스가 실행 중입니다.

절차

선택 사항: 기본 포트

514가 아닌rsyslog트래픽에 다른 포트를 사용하려면 다음을 수행합니다.syslogd_port_tSELinux 유형을 SELinux 정책 구성에 추가하고portno를rsyslog에서 사용할 포트 번호로 바꿉니다.# semanage port -a -t syslogd_port_t -p udp portno들어오는

rsyslog트래픽을 허용하고portno를 포트 번호 및영역으로교체하여rsyslog에서 사용할 영역으로 교체하도록firewalld를 구성합니다.# firewall-cmd --zone=zone --permanent --add-port=portno/udp success # firewall-cmd --reload

방화벽 규칙을 다시 로드합니다.

# firewall-cmd --reload

/etc/rsyslog파일을 생성하고 다음 내용을 삽입합니다..d/ 디렉토리(예:)에 새.confremotelogserv.conf# Define templates before the rules that use them # Per-Host templates for remote systems template(name="TmplAuthpriv" type="list") { constant(value="/var/log/remote/auth/") property(name="hostname") constant(value="/") property(name="programname" SecurePath="replace") constant(value=".log") } template(name="TmplMsg" type="list") { constant(value="/var/log/remote/msg/") property(name="hostname") constant(value="/") property(name="programname" SecurePath="replace") constant(value=".log") } # Provides UDP syslog reception module(load="imudp") # This ruleset processes remote messages ruleset(name="remote1"){ authpriv.* action(type="omfile" DynaFile="TmplAuthpriv") *.info;mail.none;authpriv.none;cron.none action(type="omfile" DynaFile="TmplMsg") } input(type="imudp" port="514" ruleset="remote1")여기서

514는 기본적으로 사용하는 포트 번호rsyslog입니다. 대신 다른 포트를 지정할 수 있습니다./etc/rsyslog.conf 파일을 확인합니다.d/ 디렉터리에 있는 /etc/rsyslogall..conf파일의 구문과# rsyslogd -N 1 rsyslogd: version 8.1911.0-2.el8, config validation run...rsyslog서비스를 다시 시작합니다.# systemctl restart rsyslog선택 사항:

rsyslog가 활성화되지 않은 경우 재부팅 후rsyslog서비스가 자동으로 시작되는지 확인하십시오.# systemctl enable rsyslog

추가 리소스

-

rsyslogd(8),rsyslog.conf(5),semanage(8)및firewall-cmd(1)도움말 페이지. -

/usr/share/doc/rsyslog/html/index.html파일의rsyslog-doc패키지와 함께 설치된 설명서입니다.

9.1.7. UDP를 통해 서버에 원격 로깅 구성

다음 절차에 따라 UDP 프로토콜을 통해 로그 메시지를 서버로 전달하기 위한 시스템을 구성합니다. omfwd 플러그인은 UDP 또는 TCP를 통해 전달을 제공합니다. 기본 프로토콜은 UDP입니다. 플러그인이 빌드되었으므로 로드할 필요가 없습니다.

사전 요구 사항

-

rsyslog패키지는 서버에 보고해야 하는 클라이언트 시스템에 설치됩니다. - UDP를 통해 원격 로깅 정보를 받기 위한 서버 구성에 설명된 대로 원격 로깅 을 위해 서버를 구성했습니다.

절차

/etc/rsyslog.d/디렉토리에 새.conf파일을 만듭니다(예:10-remotelogcli.conf).*.* action(type="omfwd" queue.type="linkedlist" queue.filename="example_fwd" action.resumeRetryCount="-1" queue.saveOnShutdown="on" target="example.com" port="portno" protocol="udp" )다음과 같습니다.

-

queue.type="linkedlist"설정은 LinkedList in-memory 큐를 활성화합니다. -

queue.filename설정은 디스크 스토리지를 정의합니다. 백업 파일은 이전 글로벌workDirectory지시문으로 지정된 작업 디렉터리에example_fwd접두사를 사용하여 생성됩니다. -

action.resumeRetryCount -1설정은 서버가 응답하지 않는 경우 연결을 재시도할 때rsyslog가 메시지를 삭제하지 않도록 합니다. -

rsyslog가 종료되면활성화된 queue.saveOnShutdown="on"설정은 메모리 내 데이터를 저장합니다. -

portno값은rsyslog에서 사용할 포트 번호입니다. 기본값은514입니다. 마지막 행은 수신된 모든 메시지를 로깅 서버로 전달하고 포트 사양은 선택 사항입니다.

이 구성을 사용하면

rsyslog에서 서버로 메시지를 전송하지만 원격 서버에 연결할 수 없는 경우 메시지를 메모리에 유지합니다. 디스크의 파일은rsyslog가 구성된 메모리 대기열 공간에서 부족하거나 시스템 성능을 향상시킬 수 있는 를 종료해야 하는 경우에만 생성됩니다.

참고rsyslog는 사전 순서로 구성 파일

/etc/rsyslog.d/를 처리합니다.-

rsyslog서비스를 다시 시작합니다.# systemctl restart rsyslog선택 사항:

rsyslog가 활성화되지 않은 경우 재부팅 후rsyslog서비스가 자동으로 시작되는지 확인하십시오.# systemctl enable rsyslog

검증

클라이언트 시스템이 서버에 메시지를 전송하는지 확인하려면 다음 단계를 따르십시오.

클라이언트 시스템에서 테스트 메시지를 전송합니다.

# logger test서버 시스템에서

/var/log/remote/msg/hostname/root.log 로그를 확인합니다.예를 들면 다음과 같습니다.# cat /var/log/remote/msg/hostname/root.log Feb 25 03:53:17 hostname root[6064]: test여기서

hostname은 클라이언트 시스템의 호스트 이름입니다. 로그에는 로거 명령을 입력한 사용자의 사용자 이름이 포함됩니다(이 경우root).

추가 리소스

-

rsyslogd(8)및rsyslog.conf(5)도움말 페이지. -

/usr/share/doc/rsyslog/html/index.html의rsyslog-doc패키지와 함께 설치된 설명서입니다.

9.1.8. Rsyslog의 로드 밸런싱 도우미

RebindInterval 설정은 현재 연결이 끊어지고 다시 설정된 간격을 지정합니다. 이 설정은 TCP, UDP 및 RELP 트래픽에 적용됩니다. 로드 밸런서는 새 연결로 인식하여 메시지를 다른 물리적 대상 시스템으로 전달합니다.

RebindInterval 설정은 대상 시스템이 IP 주소를 변경한 시나리오에서 유용합니다. Rsyslog 애플리케이션은 연결이 설정될 때 IP 주소를 캐시하므로 메시지가 동일한 서버로 전송됩니다. IP 주소가 변경되면 Rsyslog 서비스가 다시 시작될 때까지 UDP 패킷이 손실됩니다. 연결을 다시 설정하면 DNS에서 IP를 다시 확인합니다.

action(type=”omfwd” protocol=”tcp” RebindInterval=”250” target=”example.com” port=”514” …) action(type=”omfwd” protocol=”udp” RebindInterval=”250” target=”example.com” port=”514” …) action(type=”omrelp” RebindInterval=”250” target=”example.com” port=”6514” …)

9.1.9. 신뢰할 수 있는 원격 로깅 구성

RELP(Reliable Event Logging Protocol)를 사용하면 메시지 손실 위험이 훨씬 감소하여 TCP를 통해 syslog 메시지를 보내고 받을 수 있습니다. RELP는 메시지 손실이 허용되지 않는 환경에서 유용하게 이벤트 메시지를 안정적으로 전송합니다. RELP를 사용하려면 서버에서 실행되고 로그를 수신하는 imrelp 입력 모듈을 구성하고 클라이언트에서 실행되고 로깅 서버에 로그를 전송하는 omrelp 출력 모듈을 구성합니다.

사전 요구 사항

-

서버 및 클라이언트 시스템에

rsyslog,librelp및 rsyslog-relp패키지를 설치했습니다. - 지정된 포트는 SELinux에서 허용되며 방화벽에서 열립니다.

절차

안정적인 원격 로깅을 위해 클라이언트 시스템을 구성합니다.

클라이언트 시스템에서

/etc/journal.d/ 디렉토리에 새파일을 만듭니다(예:.confrelpclient.conf).module(load="omrelp") *.* action(type="omrelp" target="_target_IP_" port="_target_port_")

다음과 같습니다.

-

target_IP는 로깅 서버의 IP 주소입니다. -

target_port는 로깅 서버의 포트입니다.

-

-

/etc/octets.d/relpclient.conf파일에 변경 사항을 저장합니다. rsyslog서비스를 다시 시작합니다.# systemctl restart rsyslog선택 사항: