Red Hat Training

A Red Hat training course is available for RHEL 8

가상화 구성 및 관리

Red Hat Enterprise Linux 8의 호스트 설정, 가상 시스템 생성 및 관리, 가상화 기능 이해

초록

- 가상화의 기능 및 사용 사례

- 명령줄 유틸리티를 사용하고 웹 콘솔을 사용하여 호스트 및 가상 머신을 관리하는 방법

- Intel 64, AMD64, IBM POWER, IBM Z와 같은 다양한 시스템 아키텍처에서 가상화의 지원 제한 사항

보다 포괄적 수용을 위한 오픈 소스 용어 교체

Red Hat은 코드, 문서 및 웹 속성에서 문제가 있는 언어를 교체하기 위해 최선을 다하고 있습니다. 먼저 마스터(master), 슬레이브(slave), 블랙리스트(blacklist), 화이트리스트(whitelist) 등 네 가지 용어를 교체하고 있습니다. 이러한 변경 작업은 작업 범위가 크므로 향후 여러 릴리스에 걸쳐 점차 구현할 예정입니다. 자세한 내용은 CTO Chris Wright의 메시지를 참조하십시오.

Red Hat 문서에 관한 피드백 제공

문서에 대한 피드백에 감사드립니다. 어떻게 개선할 수 있는지 알려주십시오.

Jira를 통해 피드백 제출 (등록 필요)

- Jira 웹 사이트에 로그인합니다.

- 상단 탐색 모음에서 생성 을 클릭합니다.

- Summary (요약) 필드에 설명 제목을 입력합니다.

- Description (설명) 필드에 개선을 위한 제안을 입력합니다. 문서의 관련 부분에 대한 링크를 포함합니다.

- 대화 상자 하단에서 생성 을 클릭합니다.

1장. RHEL의 가상화 소개

가상화의 개념이나 Linux의 구현 개념에 익숙하지 않은 경우 다음 섹션에서는 RHEL 8의 가상화에 대한 개요를 제공합니다. 기본 사항, 이점, 구성 요소 및 Red Hat에서 제공하는 기타 가능한 가상화 솔루션.

1.1. 가상화란 무엇입니까?

RHEL 8에서는 RHEL 8을 실행하는 머신이 게스트라고도 하는 여러 VM(가상 머신)을 호스팅 할 수 있는 가상화 기능을 제공합니다. VM은 호스트의 물리적 하드웨어 및 컴퓨팅 리소스를 사용하여 호스트 운영 체제의 사용자 공간 프로세스로 별도의 가상화된 운영 체제(게스트 OS)를 실행합니다.

즉, 가상화를 통해 운영 체제 내에서 운영 체제를 구축할 수 있습니다.

VM을 사용하면 소프트웨어 구성 및 기능을 안전하게 테스트하거나 레거시 소프트웨어를 실행하거나 하드웨어의 워크로드 효율성을 최적화할 수 있습니다. 이점에 대한 자세한 내용은 가상화를 참조하십시오.

가상화에 대한 자세한 내용은 가상화 주제 페이지를 참조하십시오.

다음 단계

- Red Hat Enterprise Linux 8에서 가상화를 사용해 보려면 가상화 시작하기를 참조하십시오.

- Red Hat Enterprise Linux 8 가상화 외에도 Red Hat은 다양한 사용자 중심 및 기능을 갖춘 다양한 전문 가상화 솔루션을 제공합니다. 자세한 내용은 Red Hat 가상화 솔루션을 참조하십시오.

1.2. 가상화의 이점

VM(가상 머신)을 사용하면 물리적 머신 사용에 비해 다음과 같은 이점이 있습니다.

유연하고 세밀한 리소스 할당

VM은 일반적으로 물리적인 호스트 시스템에서 실행되며 게스트 OS에서 사용할 물리적 하드웨어도 할당할 수 있습니다. 그러나 VM에 물리적 리소스를 할당하는 작업은 소프트웨어 수준에서 수행되므로 매우 유연합니다. VM은 호스트 메모리, CPU 또는 스토리지 공간의 구성 요소를 사용하며 매우 세밀한 리소스 요청을 지정할 수 있습니다.

예를 들어 게스트 OS가 호스트 파일 시스템의 디스크로 표시할 수 있는 것으로 표시되는 것은 물론, 해당 디스크의 크기는 물리적 디스크에 사용 가능한 크기보다 덜 제한적입니다.

소프트웨어 제어 구성

VM의 전체 구성은 호스트에 데이터로 저장되며 소프트웨어 제어 하에 있습니다. 따라서 VM을 쉽게 생성, 제거, 복제, 마이그레이션, 작동 또는 원격 스토리지에 연결할 수 있습니다.

호스트에서 분리

게스트 OS는 호스트 OS와는 달리 가상화된 커널에서 실행됩니다. 즉, VM에 모든 OS를 설치할 수 있으며 게스트 OS가 불안정해지거나 손상된 경우에도 호스트에 영향을 주지 않습니다.

공간 및 비용 효율성

단일 물리적 시스템은 다수의 VM을 호스팅할 수 있습니다. 따라서 여러 물리적 시스템이 동일한 작업을 수행할 필요가 없으므로 물리적 하드웨어와 관련된 공간, 전력 및 유지 관리 요구 사항을 줄일 수 있습니다.

소프트웨어 호환성

VM은 호스트와 다른 OS를 사용할 수 있기 때문에 가상화를 통해 호스트 OS에 대해 원래 릴리스되지 않은 애플리케이션을 실행할 수 있습니다. 예를 들어 RHEL 7 게스트 OS를 사용하면 RHEL 8 호스트 시스템에서 RHEL 7용으로 릴리스된 애플리케이션을 실행할 수 있습니다.

참고RHEL 8 호스트에서 모든 운영 체제가 게스트 OS로 지원되는 것은 아닙니다. 자세한 내용은 RHEL 8 가상화의 권장 기능을 참조하십시오.

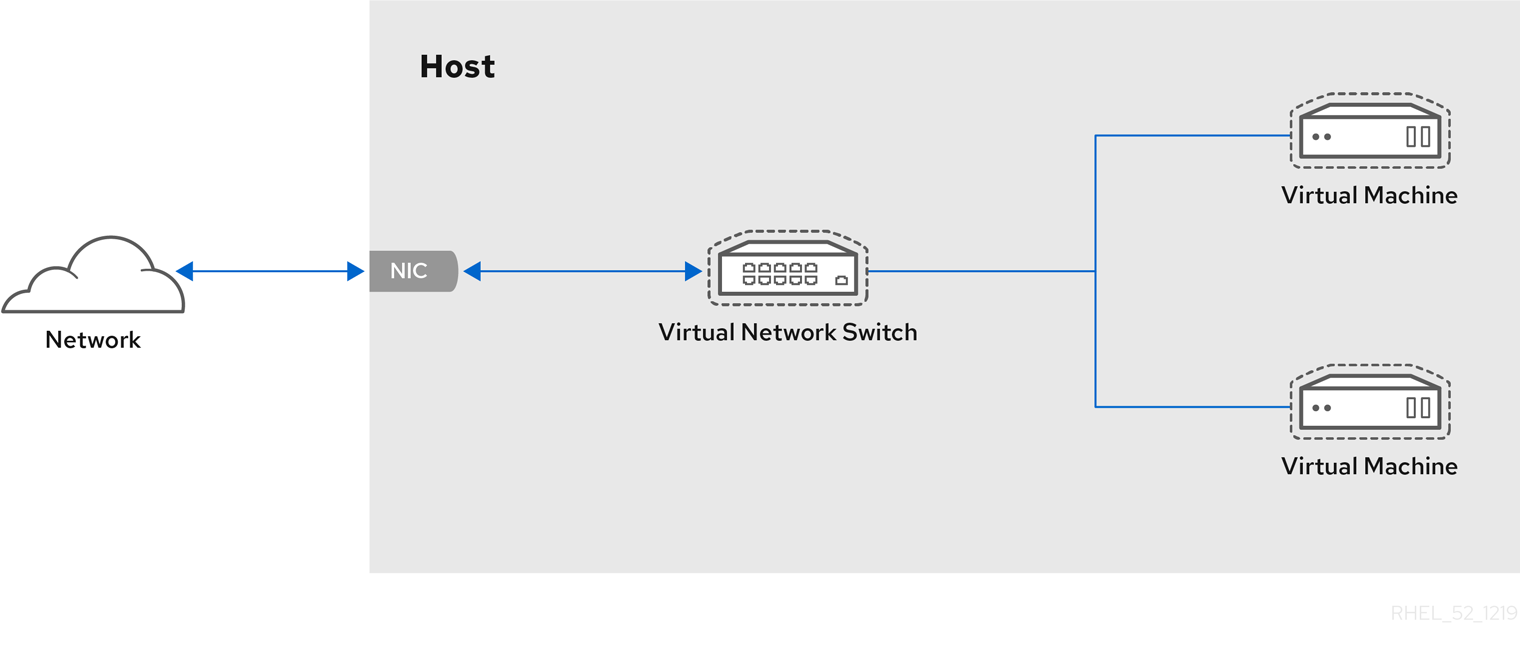

1.3. 가상 머신 구성 요소 및 상호 작용

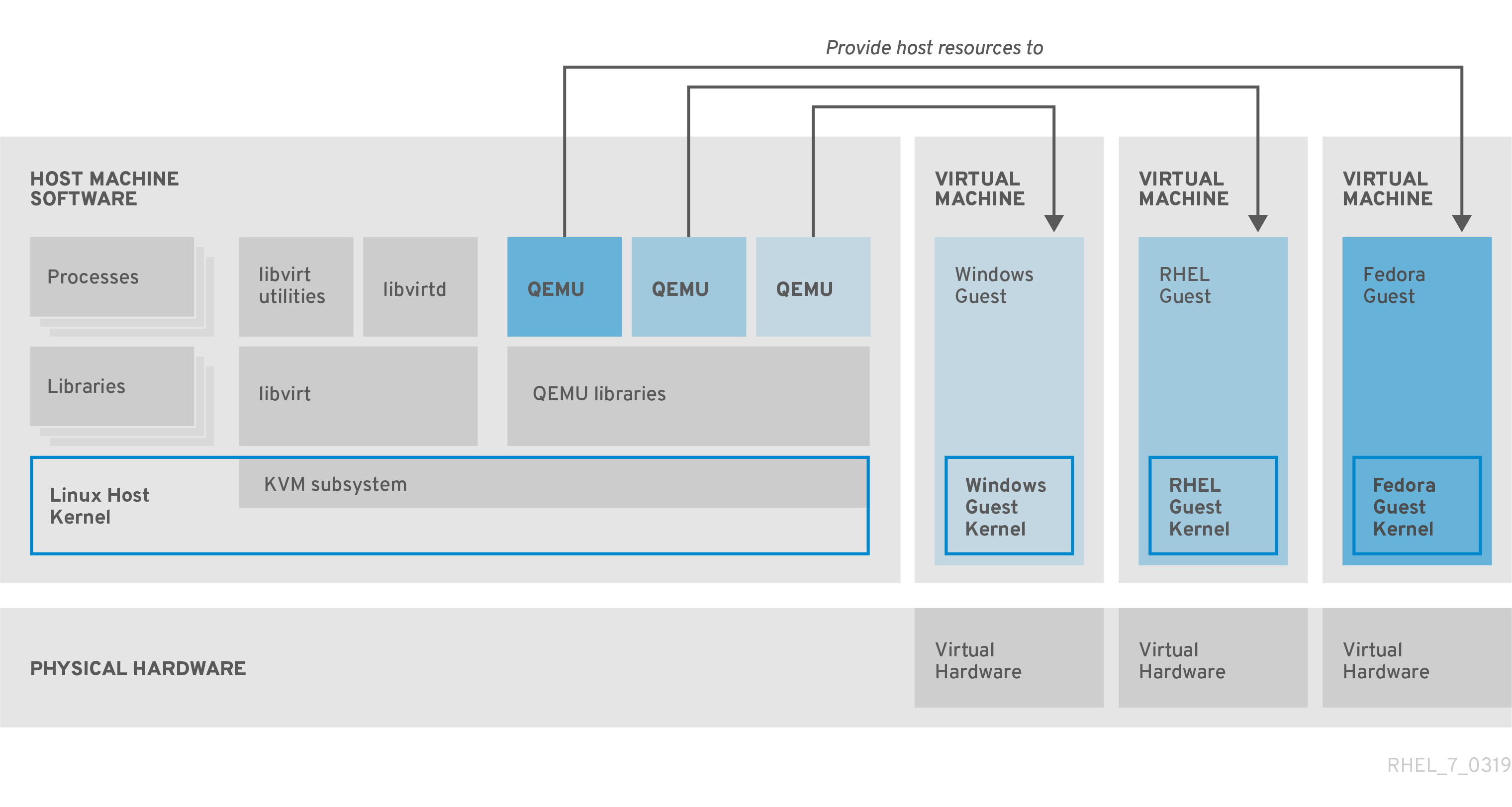

RHEL 8의 가상화는 다음과 같은 주요 소프트웨어 구성 요소로 구성됩니다.

하이퍼바이저

RHEL 8에서 VM(가상 시스템)을 생성하는 것은 하드웨어를 제어하고 호스트 시스템에서 여러 운영 체제를 실행할 수 있는 소프트웨어 계층인 하이퍼바이저 입니다.

하이퍼바이저에는 KVM(커널 기반 가상 시스템) 모듈 및 가상화 커널 드라이버가 포함되어 있습니다. 이러한 구성 요소를 사용하면 호스트 시스템의 Linux 커널이 사용자 공간 소프트웨어에 가상화를 위한 리소스를 제공할 수 있습니다.

사용자 공간 수준에서 QEMU 에뮬레이터는 게스트 운영 체제를 실행할 수 있는 완전한 가상화된 하드웨어 플랫폼을 시뮬레이션하고 호스트에 리소스를 할당하고 게스트에 제공되는 리소스를 관리합니다.

또한 libvirt 소프트웨어 제품군은 관리 및 통신 계층 역할을 하며 QEMU를 보다 쉽게 상호 작용하고 보안 규칙을 적용하며 VM 구성 및 실행을 위한 여러 추가 툴을 제공합니다.

XML 구성

호스트 기반 XML 구성 파일(도메인 XML 파일이라고도 함)은 특정 VM의 모든 설정과 장치를 결정합니다. 구성에는 다음이 포함됩니다.

- VM 이름, 시간대 및 VM에 대한 기타 정보와 같은 메타데이터입니다.

- 가상 CPU(vCPUS), 스토리지 장치, 입출력 장치, 네트워크 인터페이스 카드 및 기타 하드웨어, 실제 및 가상 하드웨어를 포함하여 VM의 장치에 대한 설명입니다.

- VM 설정(예: 사용할 수 있는 최대 메모리 양, 다시 시작 설정 및 VM 동작에 대한 기타 설정).

XML 구성 콘텐츠에 대한 자세한 내용은 샘플 가상 머신 XML 구성 을 참조하십시오.

구성 요소 상호 작용

VM이 시작되면 하이퍼바이저는 XML 구성을 사용하여 호스트에서 사용자 공간 프로세스로 VM의 인스턴스를 생성합니다. 또한 하이퍼바이저를 사용하면 virsh,virt-install, guestfish 유틸리티 또는 웹 콘솔 GUI와 같은 호스트 기반 인터페이스에서 VM 프로세스에 액세스할 수 있습니다.

이러한 가상화 도구를 사용하는 경우 libvirt는 입력을 QEMU의 지침으로 변환합니다. QEMU는 지침을 KVM에 전달하여 커널이 지침을 수행하는 데 필요한 리소스를 적절하게 할당할 수 있도록 합니다. 결과적으로 QEMU는 VM 생성 또는 수정이나 VM의 게스트 운영 체제에서 작업을 수행하는 등 해당 사용자 공간 변경 사항을 실행할 수 있습니다.

QEMU는 아키텍처의 필수 구성 요소이지만 보안 문제로 인해 RHEL 8 시스템에서 직접 사용하지는 않습니다. 따라서 qemu-* 명령은 Red Hat에서 지원되지 않으므로 libvirt를 사용하여 QEMU와 상호 작용하는 것이 좋습니다.

호스트 기반 인터페이스에 대한 자세한 내용은 가상화 관리를 위한 툴 및 인터페이스를 참조하십시오.

그림 1.1. RHEL 8 가상화 아키텍처

1.4. 가상화 관리를 위한 툴 및 인터페이스

CLI(명령줄 인터페이스) 또는 여러 GUI(그래픽 사용자 인터페이스)를 사용하여 RHEL 8에서 가상화를 관리할 수 있습니다.

명령줄 인터페이스

CLI는 RHEL 8에서 가상화를 관리하는 가장 강력한 방법입니다. VM(가상 머신) 관리를 위한 주요 CLI 명령은 다음과 같습니다.

virsh - 제공된 인수에 따라 다양한 목적을 가진 다재다능한 가상화 명령줄 유틸리티 및 쉘입니다. 예를 들면 다음과 같습니다.

-

VM 시작 및 종료 -

virsh startandvirsh shutdown -

사용 가능한 VM 나열 -

virsh list -

구성 파일에서 VM 생성 -

virsh create -

가상화 쉘 입력 -

virsh

자세한 내용은

virsh(1)도움말 페이지를 참조하십시오.-

VM 시작 및 종료 -

-

virt-install- 새 VM 생성을 위한 CLI 유틸리티. 자세한 내용은virt-install(1)도움말 페이지를 참조하십시오. -

virt-xml- VM 구성 편집을 위한 유틸리티입니다. -

guestfish- VM 디스크 이미지를 검사하고 수정하기 위한 유틸리티입니다. 자세한 내용은guestfish(1)도움말 페이지를 참조하십시오.

그래픽 인터페이스

다음 GUI를 사용하여 RHEL 8의 가상화를 관리할 수 있습니다.

Cockpit 이라고도 하는 RHEL 8 웹 콘솔 은 VM 및 가상화 호스트를 관리하기 위한 원격으로 액세스 가능하고 사용하기 쉬운 그래픽 사용자 인터페이스를 제공합니다.

웹 콘솔을 사용한 기본 가상화 관리에 대한 자세한 내용은 웹 콘솔 의 가상 머신 관리를 참조하십시오.

virt-manager(Virtual Machine Manager) 애플리케이션은 VM 및 가상화 호스트 관리를 위한 특수 GUI를 제공합니다.

중요아직 RHEL 8에서 지원되지만 virt-manager 는 더 이상 사용되지 않습니다. 웹 콘솔은 후속 릴리스에서 교체될 예정입니다. 따라서 GUI에서 가상화를 관리하는 데 웹 콘솔에 익숙해지는 것이 좋습니다.

그러나 RHEL 8에서는 일부 기능은 virt-manager 또는 명령줄에서만 액세스할 수 있습니다. 자세한 내용은 Virtual Machine Manager의 가상화 기능과 웹 콘솔 간의 차이를 참조하십시오.

Gnome Boxes 애플리케이션은 VM 및 원격 시스템을 보고 액세스할 수 있는 경량의 그래픽 인터페이스입니다. GNOME 박스는 주로 데스크탑 시스템에서 사용하도록 설계되었습니다.

중요GNOME 박스 는 GNOME 데스크탑 환경의 일부로 제공되며 RHEL 8에서 지원되지만 GUI에서 가상화를 관리하는 데 웹 콘솔을 사용하는 것이 좋습니다.

추가 리소스

1.5. Red Hat 가상화 솔루션

다음 Red Hat 제품은 RHEL 8 가상화 기능을 기반으로 구축되었으며 RHEL 8에서 사용 가능한 KVM 가상화 기능을 확장합니다. 또한 RHEL 8 가상화의 많은 제한 사항은 다음 제품에는 적용되지 않습니다.

- OpenShift Virtualization

KubeVirt 기술을 기반으로 OpenShift Virtualization은 Red Hat OpenShift Container Platform의 일부이며 컨테이너에서 가상 머신을 실행할 수 있습니다.

OpenShift Virtualization에 대한 자세한 내용은 Red Hat Hybrid Cloud 페이지를 참조하십시오.

- Red Hat OpenStack Platform (RHOSP)

Red Hat OpenStack Platform은 안전하고 안정적인 퍼블릭 또는 프라이빗 OpenStack 클라우드를 구축, 배포 및 확장할 수 있는 통합 기반을 제공합니다.

Red Hat OpenStack Platform에 대한 자세한 내용은 Red Hat Customer Portal 또는 Red Hat OpenStack Platform 설명서 제품군 을 참조하십시오.

RHEL에서 지원되지만 다른 Red Hat 가상화 솔루션에서 지원되는 가상화 기능에 대한 자세한 내용은 다음을 참조하십시오. RHEL 8 가상화에서 지원되지 않는 기능

2장. 가상화 시작하기

RHEL 8에서 가상화 를 사용하려면 아래 단계를 따르십시오. 기본 방법은 CLI(명령줄 인터페이스)를 사용하지만 사용자 편의를 위해 일부 단계는 웹 콘솔 GUI 에서 완료할 수 있습니다.

- 가상화 모듈을 활성화하고 가상화 패키지를 설치합니다. 가상화 패키지 활성화에서.

VM(가상 머신)을 생성합니다.

- CLI는 명령줄 인터페이스를 사용하여 가상 머신 생성을 참조하십시오.

- GUI의 경우 웹 콘솔을 사용하여 가상 머신 생성 및 게스트 운영 체제 설치를 참조하십시오.

VM을 시작합니다.

- CLI 는 명령줄 인터페이스를 사용하여 가상 머신 시작을 참조하십시오.

- GUI의 경우 웹 콘솔을 사용하여 가상 머신 시작을 참조하십시오.

VM에 연결합니다.

- CLI는 SSH를 사용하거나 Virt Viewer를 사용하여 가상 머신 그래픽 콘솔 열기를 사용하여 가상 머신에 연결을 참조하십시오.

- GUI의 경우 웹 콘솔을 사용하여 가상 머신과 상호 작용을 참조하십시오.

웹 콘솔은 현재 VM 관리 기능의 일부만 제공하므로 명령줄을 사용하면 RHEL 8의 고급 가상화를 사용하는 것이 좋습니다.

2.1. 가상화 활성화

RHEL 8에서 가상화를 사용하려면 가상화 모듈을 활성화하고, 가상화 패키지를 설치하고, 시스템이 VM(가상 시스템)을 호스팅하도록 구성되어 있는지 확인해야 합니다.

사전 요구 사항

- RHEL 8이 호스트 시스템에 설치 및 등록되었습니다.

시스템은 가상화 호스트로 작동하기 위한 다음 하드웨어 요구 사항을 충족합니다.

사용 가능한 최소 시스템 리소스는 다음과 같습니다.

- 호스트용 디스크 여유 공간이 6GB, 의도한 각 VM에 대해 다른 6GB가 추가됩니다.

- 호스트용 2GB RAM 및 각 VM에 대해 다른 2GB.

- 호스트의 CPU 4개. 일반적으로 VM은 할당된 단일 vCPU로 실행할 수 있지만, 높은 로드 중에 VM이 응답하지 않도록 VM당 2개 이상의 vCPU를 할당하는 것이 좋습니다.

호스트 시스템의 아키텍처는 KVM 가상화를 지원합니다.

- 특히 RHEL 8은 64비트 ARM 아키텍처(ARM 64)에서 가상화를 지원하지 않습니다.

아래 절차는 AMD64 및 Intel 64 아키텍처(x86_64)에 적용됩니다. 다른 지원 아키텍처로 호스트에서 가상화를 활성화하려면 다음 섹션 중 하나를 참조하십시오.

절차

RHEL 8 가상화 모듈에 패키지를 설치합니다.

# yum module install virtvirt-install및virt-viewer패키지를 설치합니다.# yum install virt-install virt-viewerlibvirtd서비스를 시작합니다.# systemctl start libvirtd

검증

시스템이 가상화 호스트가 될 준비가 되었는지 확인합니다.

# virt-host-validate [...] QEMU: Checking for device assignment IOMMU support : PASS QEMU: Checking if IOMMU is enabled by kernel : WARN (IOMMU appears to be disabled in kernel. Add intel_iommu=on to kernel cmdline arguments) LXC: Checking for Linux >= 2.6.26 : PASS [...] LXC: Checking for cgroup 'blkio' controller mount-point : PASS LXC: Checking if device /sys/fs/fuse/connections exists : FAIL (Load the 'fuse' module to enable /proc/ overrides)virt-host-validate검사의 반환 값을 검토하고 적절한 작업을 수행합니다.-

모든

virt-host-validate검사에서PASS값을 반환하는 경우 시스템은 VM을 생성할 준비가 된 것입니다. -

검사 중

실패값을 반환하는 경우 표시된 지침에 따라 문제를 해결합니다. -

검사 중

WARN값을 반환하는 경우 표시된 지침에 따라 가상화 기능을 개선하십시오.

-

모든

문제 해결

호스트 CPU에서 KVM 가상화를 지원하지 않는 경우

virt-host-validate는 다음 출력을 생성합니다.QEMU: Checking for hardware virtualization: FAIL (Only emulated CPUs are available, performance will be significantly limited)

그러나 이러한 호스트 시스템의 VM은 성능 문제가 아닌 부팅에 실패합니다.

이 문제를 해결하려면 VM의 XML 구성에서 &

lt;domain type> 값을qemu로 변경할 수 있습니다. 그러나 Red Hat은qemu도메인 유형을 사용하는 VM을 지원하지 않으며 프로덕션 환경에서는 사용하지 않는 것이 좋습니다.

2.2. 가상 머신 생성

RHEL 8에서 VM(가상 머신)을 생성하려면 명령줄 인터페이스 또는 RHEL 8 웹 콘솔 을 사용합니다.

2.2.1. 명령줄 인터페이스를 사용하여 가상 머신 생성

virt-install 유틸리티를 사용하여 RHEL 8 호스트에 VM(가상 머신)을 생성하려면 아래 지침을 따르십시오.

사전 요구 사항

- 가상화가 호스트 시스템에서 활성화됩니다.

- 디스크 공간, RAM 또는 CPU와 같이 VM에 할당할 충분한 시스템 리소스가 있습니다. 권장 값은 VM의 의도한 작업 및 워크로드에 따라 크게 달라질 수 있습니다.

OS(운영 체제) 설치 소스는 로컬 또는 네트워크에서 사용할 수 있습니다. 다음 중 하나일 수 있습니다.

- 설치 미디어의 ISO 이미지

기존 VM 설치의 디스크 이미지

주의RHEL 8에서는 호스트 CD-ROM 또는 DVD-ROM 장치에서 설치할 수 없습니다. RHEL 8에서 사용할 수 있는 VM 설치 방법을 사용할 때 CD-ROM 또는 DVD-ROM을 설치 소스로 선택하면 설치에 실패합니다. 자세한 내용은 Red Hat 지식베이스 를 참조하십시오.

또한 Red Hat은 제한된 게스트 운영 체제 세트에 대해서만 지원을 제공합니다.

- 선택 사항: Kickstart 파일을 제공하여 설치 시 보다 빠르고 쉽게 구성할 수 있습니다.

절차

VM을 생성하고 OS 설치를 시작하려면 다음 필수 인수와 함께 virt-install 명령을 사용합니다.

-

--name: 새 머신의 이름 -

--memory: 할당된 메모리 양 -

--vCPUs: 할당된 가상 CPU 수 -

--disk: 할당된 스토리지의 유형 및 크기 -

--CDROM 또는--location: OS 설치 소스의 유형 및 위치

선택한 설치 방법에 따라 필요한 옵션과 값은 다를 수 있습니다. 예는 아래 명령을 참조하십시오.

나열된 명령은 기본 SPICE 프로토콜 대신 VNC 원격 디스플레이 프로토콜을 사용합니다. VNC에는 현재 SPICE가 수행하는 일부 기능은 없지만 RHEL 9에서 완전히 지원됩니다. 결과적으로 호스트를 RHEL 9로 마이그레이션하면 VNC를 사용하는 VM이 작동하지 않습니다. 자세한 내용은 RHEL 9 도입의 고려 사항을 참조하십시오.

다음 명령은 /home/username/Downloads/Win10install.iso 파일에 로컬로 저장된 ISO 이미지에서 Windows 10 OS를 설치하는 demo-guest1 이라는 VM을 생성합니다. 또한 이 VM은 2048MiB RAM과 2개의 vCPU로 할당되며, 80GiB qcow2 가상 디스크도 자동으로 VM에 대해 구성됩니다.

# virt-install \ --graphics vnc \ --name demo-guest1 --memory 2048 \ --vcpus 2 --disk size=80 --os-variant win10 \ --cdrom /home/username/Downloads/Win10install.iso

다음 명령은 /home/username/Downloads/rhel8.iso 이미지를 사용하여 라이브 CD에서 RHEL 8 OS를 실행하는 demo-guest2 라는 VM을 생성합니다. 이 VM에 디스크 공간이 할당되지 않으므로 세션 중에 변경한 내용은 유지되지 않습니다. 또한 VM에는 4096MiB의 RAM과 4개의 vCPU가 할당됩니다.

# virt-install \ --graphics vnc \ --name demo-guest2 --memory 4096 --vcpus 4 \ --disk none --livecd --os-variant rhel8.0 \ --cdrom /home/username/Downloads/rhel8.iso

다음 명령은 기존 디스크 이미지 /home/username/backup/disk.qcow2 에 연결하는 demo-guest3 이라는 RHEL 8 VM을 생성합니다. 이것은 시스템 간에 하드 드라이브를 물리적으로 이동하는 것과 비슷하므로, demo-guest3에서 사용할 수 있는 OS와 데이터는 이전에 이미지를 처리한 방법에 따라 결정됩니다. 또한 이 VM에는 2048MiB RAM과 2개의 vCPU가 할당됩니다.

# virt-install \ --graphics vnc \ --name demo-guest3 --memory 2048 --vcpus 2 \ --os-variant rhel8.0 --import \ --disk /home/username/backup/disk.qcow2

디스크 이미지를 가져올 때

--os-variant옵션을 사용하는 것이 좋습니다. 제공되지 않으면 생성된 VM의 성능에 부정적인 영향을 미칩니다.다음 명령은

http://example.com/OS-installURL에서 설치하는 demo-guest4 라는 VM을 생성합니다. 설치가 성공적으로 시작하려면 URL에 작동 중인 OS 설치 트리가 포함되어야 합니다. 또한 OS는 /home/username/ks.cfg kickstart 파일을 사용하여 자동으로 구성됩니다. 이 VM은 2048MiB RAM, vCPU 2개, 160GiB qcow2 가상 디스크도 함께 할당됩니다.# virt-install \ --graphics vnc \ --name demo-guest4 --memory 2048 --vcpus 2 --disk size=160 \ --os-variant rhel8.0 --location http://example.com/OS-install \ --initrd-inject /home/username/ks.cfg --extra-args="inst.ks=file:/ks.cfg console=tty0 console=ttyS0,115200n8"

다음 명령은 그래픽 없이

RHEL8.iso이미지 파일에서 텍스트 전용 모드로 설치하는 demo-guest5 라는 VM을 생성합니다. 게스트 콘솔을 직렬 콘솔에 연결합니다. VM에는 16384MiB 메모리, 16 vCPU 및 280GiB 디스크가 있습니다. 이러한 종류의 설치는 느린 네트워크 링크를 통해 호스트에 연결할 때 유용합니다.# virt-install \ --name demo-guest5 --memory 16384 --vcpus 16 --disk size=280 \ --os-variant rhel8.0 --location RHEL8.iso \ --graphics none --extra-args='console=ttyS0'

다음 명령은 demo-guest5와 동일하지만 192.0.2.1 원격 호스트에 상주하는 demo-guest6 이라는 VM을 생성합니다.

# virt-install \ --connect qemu+ssh://root@192.0.2.1/system --name demo-guest6 --memory 16384 \ --vcpus 16 --disk size=280 --os-variant rhel8.0 --location RHEL8.iso \ --graphics none --extra-args='console=ttyS0'

검증

- VM이 성공적으로 생성되면 VM의 그래픽 콘솔로 virt-viewer 창이 열리고 게스트 OS 설치를 시작합니다.

문제 해결

virt-install이 실패하고기본 네트워크 오류를 찾을 수 없는경우:libvirt-daemon-config-network패키지가 설치되었는지 확인합니다.# {PackageManagerCommand} info libvirt-daemon-config-network Installed Packages Name : libvirt-daemon-config-network [...]libvirt기본 네트워크가 활성 상태이며 자동으로 시작되도록 구성되어 있는지 확인합니다.# virsh net-list --all Name State Autostart Persistent -------------------------------------------- default active yes yes기본 네트워크를 활성화하여 자동 시작으로 설정합니다.

# virsh net-autostart default Network default marked as autostarted # virsh net-start default Network default started

다음 오류와 함께 기본 네트워크를 활성화하면

libvirt-daemon-config-network패키지가 올바르게 설치되지 않았습니다.error: failed to get network 'default' error: Network not found: no network with matching name 'default'

이 문제를 해결하려면

libvirt-daemon-config-network를 다시 설치합니다.# {PackageManagerCommand} reinstall libvirt-daemon-config-network다음과 유사한 오류로 기본 네트워크를 활성화하지 못하면 기본 네트워크의 서브넷과 호스트의 기존 인터페이스 사이에 충돌이 발생했습니다.

error: Failed to start network default error: internal error: Network is already in use by interface ens2

이 문제를 해결하려면

virsh net-edit 기본명령을 사용하고 구성의192.0.2.*값을 호스트에서 사용하지 않은 서브넷으로 변경합니다.

추가 리소스

-

virt-install(1)도움말 페이지 - 웹 콘솔을 사용하여 가상 머신 생성 및 게스트 운영 체제 설치

- 가상 머신 복제

2.2.2. 웹 콘솔을 사용하여 가상 머신 생성 및 게스트 운영 체제 설치

RHEL 8 호스트의 GUI에서 VM(가상 시스템)을 관리하려면 웹 콘솔을 사용합니다. 다음 섹션에서는 RHEL 8 웹 콘솔을 사용하여 VM을 생성하고 게스트 운영 체제를 설치하는 방법에 대한 정보를 제공합니다.

웹 콘솔을 사용하여 생성된 VM은 현재 기본적으로 SPICE 원격 데스크탑 프로토콜을 사용합니다. 그러나 RHEL 9에서는 SPICE가 지원되지 않으므로 호스트를 RHEL 9로 업그레이드하는 경우 VM이 작동하지 않습니다. 자세한 내용은 RHEL 9 도입의 고려 사항을 참조하십시오.

RHEL 9에서 올바르게 작동하는 VNC 프로토콜을 사용하는 VM 을 생성하려면 명령줄 인터페이스를 사용합니다.

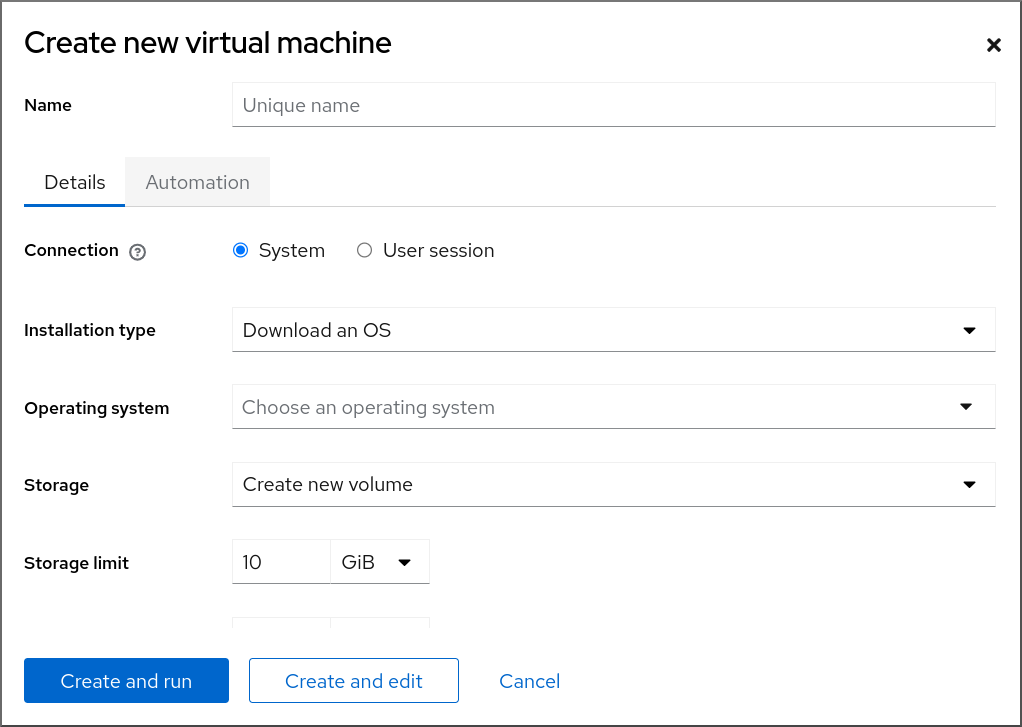

2.2.2.1. 웹 콘솔을 사용하여 가상 머신 생성

RHEL 8 웹 콘솔이 연결된 호스트 머신에 VM(가상 머신)을 생성하려면 아래 지침을 사용하십시오.

사전 요구 사항

- 호스트 시스템에서 가상화가 활성화되어 있습니다.

- 웹 콘솔 VM 플러그인이 호스트 시스템에 설치되어 있습니다.

- 디스크 공간, RAM 또는 CPU와 같이 VM에 할당할 충분한 시스템 리소스가 있습니다. 권장 값은 의도한 작업 및 VM의 워크로드에 따라 크게 다를 수 있습니다.

절차

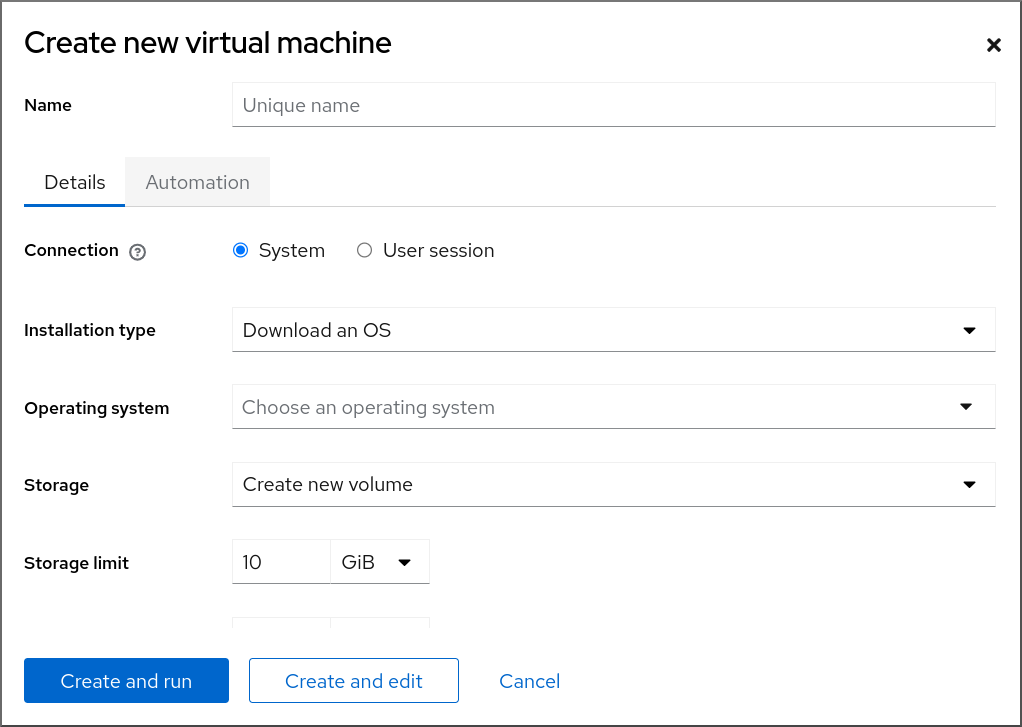

웹 콘솔 의 가상 머신 인터페이스에서 Create VM 을 클릭합니다.

새 가상 머신 생성 대화 상자가 표시됩니다.

생성할 VM의 기본 구성을 입력합니다.

- Name (이름) - VM의 이름입니다.

- 연결 - 세션에 부여된 권한 수준입니다. 자세한 내용은 웹 콘솔에서 연결된 대화 상자를 확장합니다.

- 설치 유형 - 설치 시 로컬 설치 미디어, URL, PXE 네트워크 부팅, 클라우드 기본 이미지를 사용하거나 제한된 운영 체제 세트에서 운영 체제를 다운로드할 수 있습니다.

운영 체제 - VM에서 실행되는 게스트 운영 체제입니다. Red Hat은 제한된 게스트 운영 체제 세트 에서만 지원합니다.

참고웹 콘솔에서 직접 Red Hat Enterprise Linux를 다운로드하고 설치하려면 오프라인 토큰 필드에 오프라인 토큰을 추가해야 합니다.

- storage - 스토리지의 유형입니다.

- 스토리지 제한 - 스토리지 공간의 크기입니다.

- memory - 메모리 양입니다.

VM을 생성합니다.

- VM이 운영 체제를 자동으로 설치하도록 하려면 생성을 클릭하고 실행합니다.

- 운영 체제가 설치되기 전에 VM을 편집하려면 생성을 클릭하고 편집합니다.

다음 단계

추가 리소스

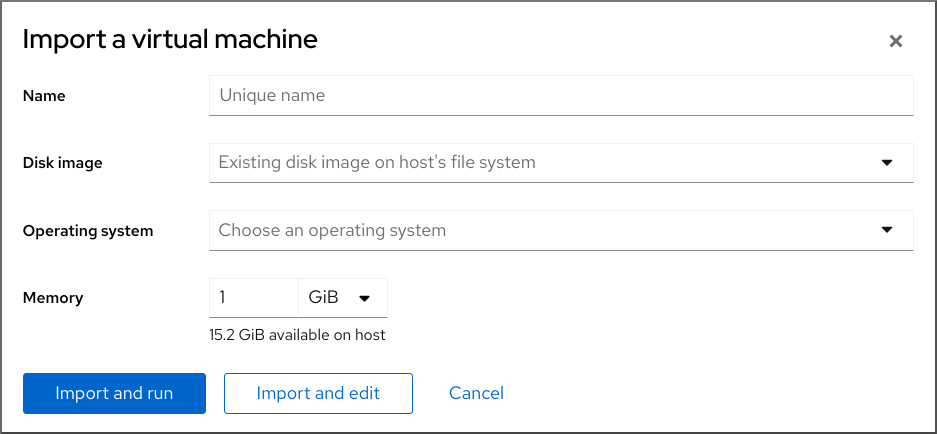

2.2.2.2. 웹 콘솔을 사용하여 디스크 이미지를 가져와 가상 머신 생성

RHEL 8 웹 콘솔에서 기존 VM 설치의 디스크 이미지를 가져와 VM(가상 머신)을 생성할 수 있습니다.

사전 요구 사항

- 웹 콘솔 VM 플러그인이 시스템에 설치되어 있습니다.

- 디스크 공간, RAM 또는 CPU와 같이 VM에 할당할 충분한 시스템 리소스가 있습니다. 권장 값은 VM의 의도한 작업 및 워크로드에 따라 크게 달라질 수 있습니다.

- 기존 VM 설치의 디스크 이미지를 다운로드했습니다.

절차

웹 콘솔 의 가상 머신 인터페이스에서 VM 가져오기 를 클릭합니다.

가상 머신 가져오기 대화 상자가 표시됩니다.

생성할 VM의 기본 구성을 입력합니다.

- Name (이름) - VM의 이름입니다.

- 디스크 이미지 - 호스트 시스템에 있는 VM의 기존 디스크 이미지 경로입니다.

- 운영 체제 - VM 디스크에서 실행되는 운영 체제입니다. Red Hat은 제한된 게스트 운영 체제 세트 에서만 지원합니다.

- memory - VM에서 사용할 메모리 양입니다.

VM을 가져옵니다.

- VM 설정에 대한 추가 편집 없이 VM에 운영 체제를 설치하려면 가져오기 및 실행을 클릭합니다.

- 운영 체제를 설치하기 전에 VM 설정을 편집하려면 가져오기 및 편집을 클릭합니다.

2.2.2.3. 웹 콘솔을 사용하여 게스트 운영 체제 설치

VM(가상 머신)이 처음 부팅되는 경우 VM에 운영 체제를 설치해야 합니다.

새 VM을 생성하는 동안 생성 및 실행 또는 실행을 클릭하면 VM이 생성될 때 운영 체제의 설치 루틴이 자동으로 시작됩니다.

사전 요구 사항

절차

가상 머신 인터페이스에서 게스트 OS를 설치할 VM을 클릭합니다.

선택한 VM에 대한 기본 정보와 VM의 다양한 측면을 관리하기 위한 컨트롤이 포함된 새 페이지가 열립니다.

선택 사항: 펌웨어를 변경합니다.

참고새 VM을 생성하는 동안 생성 및 편집 또는 편집 및 OS가 VM에 아직 설치되지 않은 경우에만 펌웨어를 변경할 수 있습니다.

- 펌웨어를 클릭합니다.

- 펌웨어 변경 창에서 필요한 펌웨어를 선택합니다.

- 저장을 클릭합니다.

설치를 클릭합니다.

운영 체제의 설치 루틴은 VM 콘솔에서 실행됩니다.

문제 해결

- 설치 루틴이 실패하면 설치를 다시 시작하기 전에 VM을 삭제하고 다시 생성합니다.

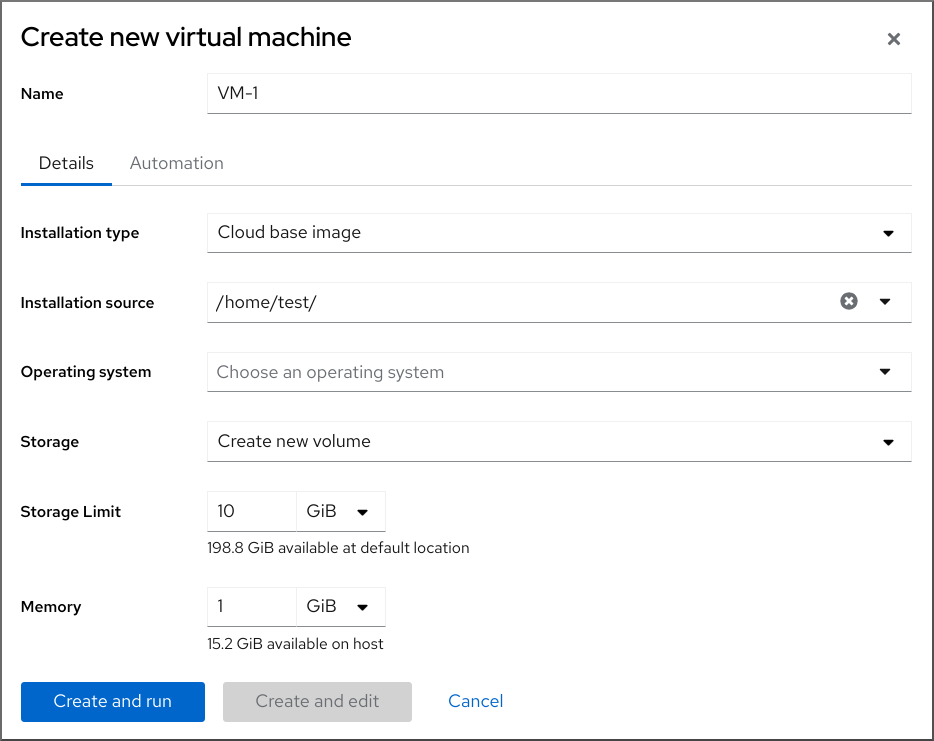

2.2.3. 웹 콘솔을 사용하여 클라우드 이미지 인증으로 가상 머신 생성

기본적으로 클라우드 이미지에는 로그인 계정이 없습니다. 그러나 RHEL 웹 콘솔을 사용하면 이제 VM(가상 머신)을 생성하고 root 및 사용자 계정 로그인 인증 정보를 지정할 수 있습니다. 이 인증 정보는 cloud-init로 전달됩니다.

사전 요구 사항

절차

웹 콘솔의 Virtual Machines(가상 시스템 ) 인터페이스에서 Create VM(VM 만들기 )을 클릭합니다.

Create new virtual machine(새 가상 머신 만들기) 대화 상자가 표시됩니다.

- 이름 필드에 VM의 이름을 입력합니다.

세부 정보 탭의 설치 유형 필드에서 클라우드 기본 이미지를 선택합니다.

- 설치 소스 필드에서 호스트 시스템의 이미지 파일 경로를 설정합니다.

생성할 VM의 구성을 입력합니다.

- 운영 체제 - VM의 운영 체제. Red Hat은 제한된 게스트 운영 체제 세트 에서만 지원합니다.

- Storage (스토리지) - VM을 구성할 스토리지 유형입니다.

- Storage Limit - VM을 구성할 스토리지 공간의 양입니다.

- memory - VM을 구성할 메모리 양입니다.

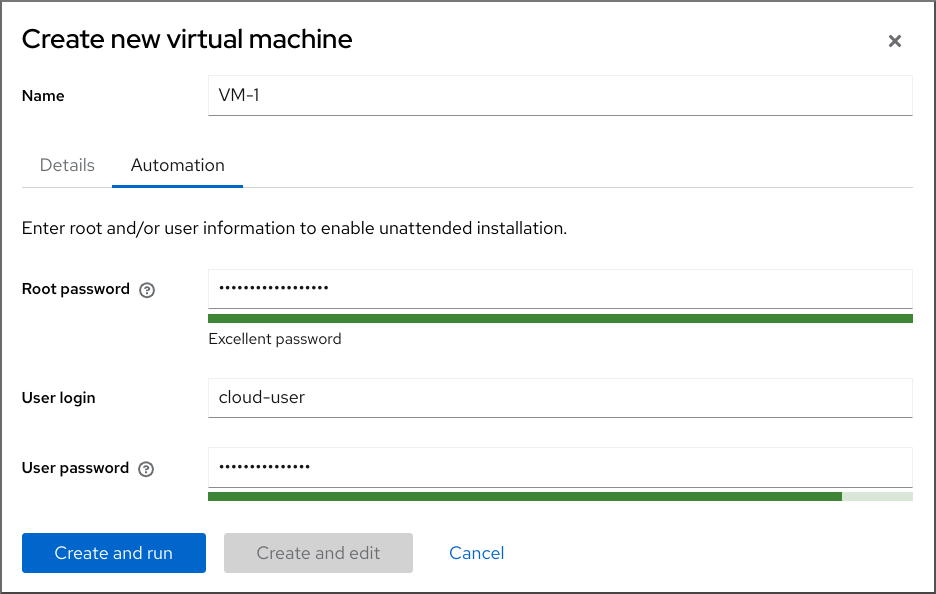

자동화 탭을 클릭합니다.

클라우드 인증 자격 증명을 설정합니다.

- 루트 암호 - VM의 루트 암호를 입력합니다. 루트 암호를 설정하지 않으려면 필드를 비워 둡니다.

- 사용자 로그인 - cloud-init 사용자 로그인을 입력합니다. 사용자 계정을 생성하지 않으려면 이 필드를 비워 둡니다.

사용자 암호 - 암호를 입력합니다. 사용자 계정을 생성하지 않으려면 이 필드를 비워 둡니다.

생성을 클릭하고 실행합니다.

VM이 생성됩니다.

추가 리소스

2.3. 가상 머신 시작

RHEL 8에서 VM(가상 머신)을 시작하려면 명령줄 인터페이스 또는 웹 콘솔 GUI 를 사용할 수 있습니다.

사전 요구 사항

- VM을 시작하기 전에 VM을 만들고, 이상적으로 OS를 사용하여 설치해야 합니다. 이를 수행하는 방법은 가상 머신 생성을 참조하십시오.

2.3.1. 명령줄 인터페이스를 사용하여 가상 머신 시작

CLI(명령줄 인터페이스)를 사용하여 종료한 VM(가상 머신)을 시작하거나 저장된 VM을 복원할 수 있습니다. CLI를 사용하면 로컬 및 원격 VM을 모두 시작할 수 있습니다.

사전 요구 사항

- 이미 정의된 비활성 VM입니다.

- VM의 이름입니다.

원격 VM의 경우:

- VM이 있는 호스트의 IP 주소입니다.

- 호스트에 대한 루트 액세스 권한.

절차

로컬 VM의 경우

virsh start유틸리티를 사용합니다.예를 들어 다음 명령은 demo-guest1 VM을 시작합니다.

# virsh start demo-guest1 Domain 'demo-guest1' started원격 호스트에 있는 VM의 경우 호스트에 대한 QEMU+SSH 연결과 함께

virsh start유틸리티를 사용합니다.예를 들어 다음 명령은 192.0.2.1 호스트에서 demo-guest1 VM을 시작합니다.

# virsh -c qemu+ssh://root@192.0.2.1/system start demo-guest1 root@192.0.2.1's password: Domain 'demo-guest1' started

추가 리소스

-

virsh start --help명령 - 원격 가상화 호스트에 쉽게 액세스 가능

- 호스트가 시작될 때 자동으로 가상 머신 시작

2.3.2. 웹 콘솔을 사용하여 가상 머신 시작

VM(가상 머신)이 shut off 상태인 경우 RHEL 8 웹 콘솔을 사용하여 시작할 수 있습니다. 호스트가 시작될 때 VM이 자동으로 시작하도록 구성할 수도 있습니다.

사전 요구 사항

- 웹 콘솔 VM 플러그인이 시스템에 설치되어 있습니다.

- 이미 정의된 비활성 VM입니다.

- VM의 이름입니다.

절차

Virtual Machines (가상 시스템) 인터페이스에서 시작할 VM을 클릭합니다.

선택한 VM에 대한 자세한 정보와 VM 종료 및 삭제를 위한 컨트롤이 포함된 새 페이지가 열립니다.

Run(실행)을 클릭합니다.

VM이 시작되고 콘솔 또는 그래픽 출력에 연결할 수 있습니다.

선택 사항: 호스트가 시작될 때 자동으로 시작되도록 VM을 구성하려면 Overview 섹션의

Autostart확인란을 전환합니다.libvirt에서 관리하지 않는 네트워크 인터페이스를 사용하는 경우 systemd 구성도 변경해야 합니다. 그렇지 않으면 영향을 받는 VM이 시작되지 못할 수 있습니다. 호스트가 시작될 때 자동으로 가상 시스템 시작을 참조하십시오.

2.3.3. 호스트가 시작될 때 자동으로 가상 시스템 시작

VM(가상 머신)이 실행 중인 호스트가 다시 시작되면 VM이 종료되며 기본적으로 다시 시작해야 합니다. 호스트가 실행될 때마다 VM이 활성화되도록 하려면 VM을 자동으로 시작하도록 구성할 수 있습니다.

사전 요구 사항

절차

virsh 자동 시작유틸리티를 사용하여 호스트가 시작될 때 자동으로 시작하도록 VM을 구성합니다.예를 들어 다음 명령은 자동으로 시작되도록 demo-guest1 VM을 구성합니다.

# virsh autostart demo-guest1 Domain 'demo-guest1' marked as autostarted

libvirt에서 관리하지 않는 네트워크 인터페이스를 사용하는 경우 systemd 구성을 추가로 변경해야 합니다. 그렇지 않으면 영향을 받는 VM이 시작되지 못할 수 있습니다.참고이러한 인터페이스는 예를 들면 다음과 같습니다.

-

NetworkManager에서 만든 브리지 장치 -

<forward mode='bridge'/>를 사용하도록 구성된 네트워크

systemd 구성 디렉터리 트리에서

libvirtd.service.d디렉터리가 아직 없는 경우 생성합니다.# mkdir -p /etc/systemd/system/libvirtd.service.d/이전에 생성한 디렉터리에

10-network-online.confsystemd 장치 재정의 파일을 만듭니다. 이 파일의 내용은 libvirtd 서비스의 기본 systemd 구성을 덮어씁니다.# touch /etc/systemd/system/libvirtd.service.d/10-network-online.conf10-network-online.conf파일에 다음 행을 추가합니다. 이 구성 변경을 통해 systemd는 호스트의 네트워크가 준비된 후에만libvirtd서비스를 시작합니다.[Unit] After=network-online.target

-

검증

VM 구성을 보고 autostart 옵션이 활성화되었는지 확인합니다.

예를 들어 다음 명령은 autostart 옵션을 포함하여 demo-guest1 VM에 대한 기본 정보를 표시합니다.

# virsh dominfo demo-guest1 Id: 2 Name: demo-guest1 UUID: e46bc81c-74e2-406e-bd7a-67042bae80d1 OS Type: hvm State: running CPU(s): 2 CPU time: 385.9s Max memory: 4194304 KiB Used memory: 4194304 KiB Persistent: yes Autostart: enable Managed save: no Security model: selinux Security DOI: 0 Security label: system_u:system_r:svirt_t:s0:c873,c919 (enforcing)libvirt에서 관리하지 않는 네트워크 인터페이스를 사용하는 경우

10-network-online.conf파일의 콘텐츠가 다음 출력과 일치하는지 확인합니다.$ cat /etc/systemd/system/libvirtd.service.d/10-network-online.conf [Unit] After=network-online.target

추가 리소스

-

virsh autostart --help명령 - 웹 콘솔을 사용하여 가상 머신 시작.

2.4. 가상 머신에 연결

RHEL 8의 VM(가상 머신)과 상호 작용하려면 다음 중 하나를 수행하여 연결해야 합니다.

- 웹 콘솔 인터페이스를 사용하는 경우 웹 콘솔 인터페이스의 Virtual Machines(가상 시스템) 창을 사용합니다. 자세한 내용은 웹 콘솔을 사용하여 가상 머신과 상호 작용을 참조하십시오.

- 웹 콘솔을 사용하지 않고 VM 그래픽 디스플레이와 상호 작용해야 하는 경우 Virt Viewer 애플리케이션을 사용합니다. 자세한 내용은 Virt Viewer를 사용하여 가상 머신 그래픽 콘솔 열기를 참조하십시오.

- 그래픽 디스플레이를 사용할 수 없거나 필요하지 않은 경우 SSH 터미널 연결을 사용합니다.

- 네트워크를 사용하여 시스템에서 가상 시스템에 연결할 수 없는 경우 virsh 콘솔을 사용합니다.

연결하는 VM이 로컬 호스트가 아닌 원격 호스트에 있는 경우 선택적으로 원격 호스트에 대한 보다 편리한 액세스를 위해 시스템을 구성할 수 있습니다.

2.4.1. 웹 콘솔을 사용하여 가상 머신과 상호 작용

RHEL 8 웹 콘솔에서 VM(가상 머신)과 상호 작용하려면 VM의 콘솔에 연결해야 합니다. 여기에는 그래픽 콘솔과 직렬 콘솔이 포함됩니다.

- 웹 콘솔에서 VM의 그래픽 인터페이스와 상호 작용하려면 그래픽 콘솔을 사용합니다.

- 원격 뷰어에서 VM의 그래픽 인터페이스와 상호 작용하려면 원격 뷰어 에서 그래픽 콘솔을 사용합니다.

- 웹 콘솔에서 VM의 CLI와 상호 작용하려면 직렬 콘솔을 사용합니다.

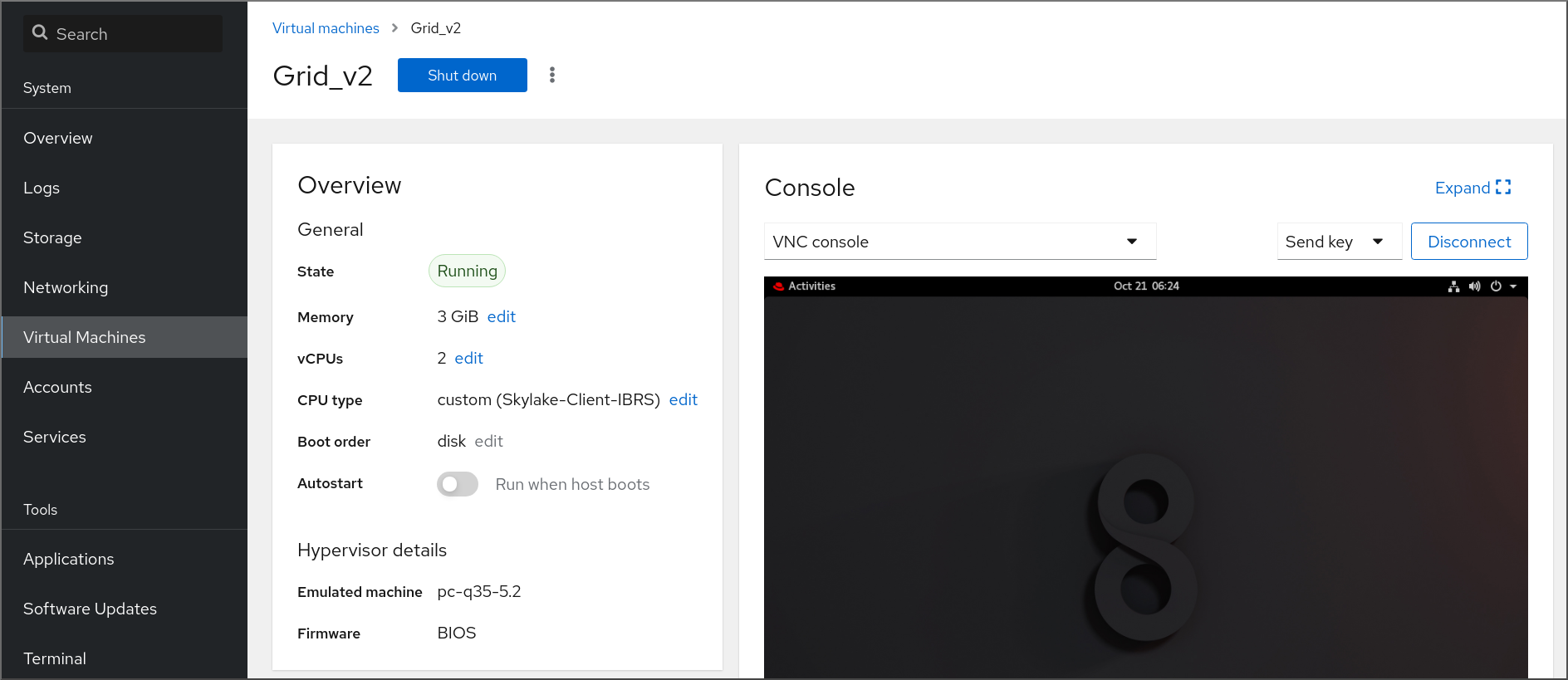

2.4.1.1. 웹 콘솔에서 가상 머신 그래픽 콘솔 보기

VM(가상 머신) 콘솔 인터페이스를 사용하면 RHEL 8 웹 콘솔에서 선택한 VM의 그래픽 출력을 볼 수 있습니다.

사전 요구 사항

- 웹 콘솔 VM 플러그인이 시스템에 설치되어 있습니다.

- 호스트와 VM이 모두 그래픽 인터페이스를 지원하는지 확인합니다.

절차

Virtual Machines (가상 시스템) 인터페이스에서 볼 그래픽 콘솔이 있는 VM을 클릭합니다.

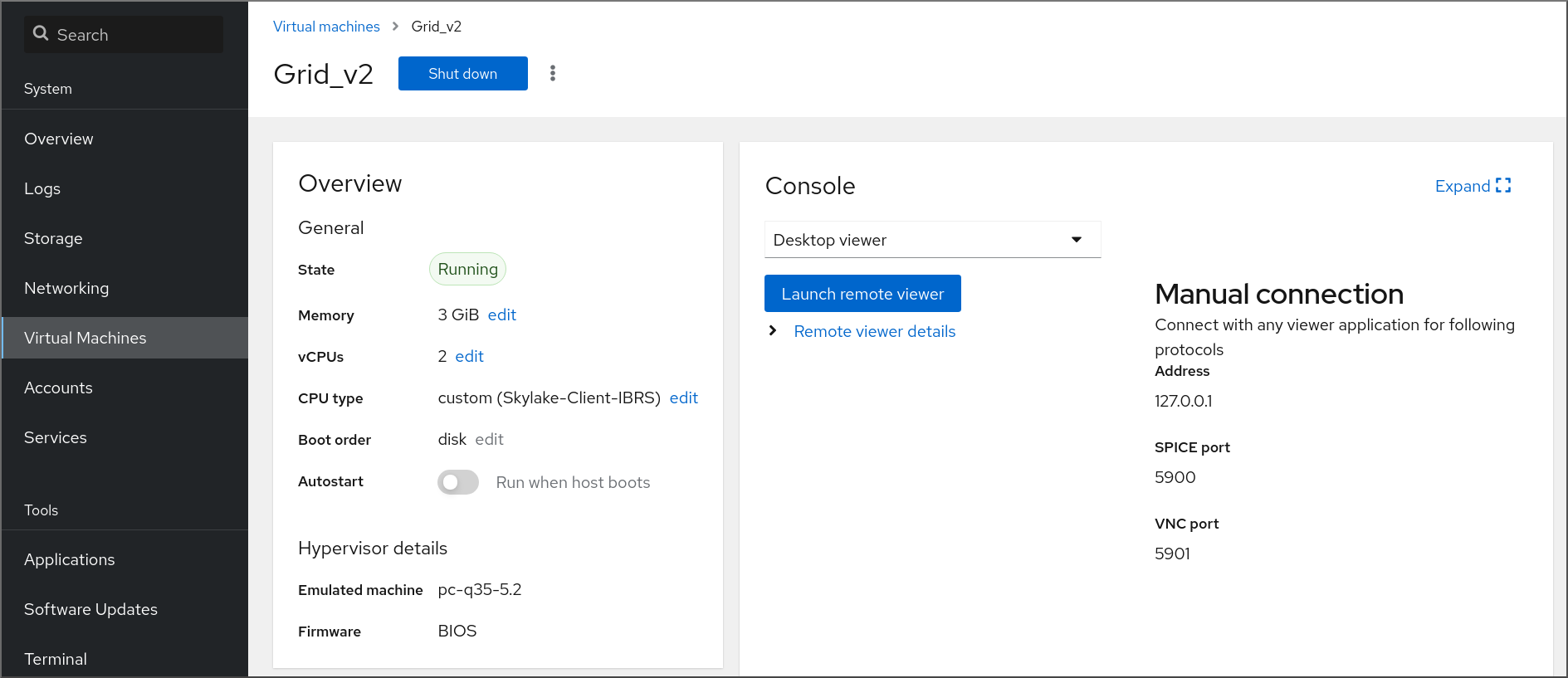

VM에 대한 개요 및 콘솔 섹션이 포함된 새 페이지가 열립니다.

콘솔 드롭다운 메뉴에서 VNC 콘솔을 선택합니다.

VNC 콘솔은 웹 인터페이스의 메뉴 아래에 표시됩니다.

그래픽 콘솔이 웹 인터페이스에 나타납니다.

Expand(확장)를클릭합니다.

이제 실제 시스템과 상호 작용하는 것과 동일한 방식으로 마우스 및 키보드를 사용하여 VM 콘솔과 상호 작용할 수 있습니다. VM 콘솔의 디스플레이는 VM에서 수행 중인 활동을 반영합니다.

웹 콘솔이 실행 중인 호스트는 Ctrl+Alt+Del 과 같은 특정 키 조합을 가로채어 VM으로 전송되지 않을 수 있습니다.

이러한 키 조합을 보내려면 키 보내기 메뉴를 클릭하고 전송할 키 시퀀스를 선택합니다.

예를 들어 Ctrl+Alt+Del 조합을 VM으로 보내려면 Send(보내기) 키를 클릭하고 Ctrl+Alt+Del 메뉴 항목을 선택합니다.

문제 해결

- 그래픽 콘솔을 클릭해도 효과가 없으면 콘솔을 전체 화면으로 확장하십시오. 이는 마우스 커서 오프셋의 알려진 문제입니다.

2.4.1.2. 웹 콘솔을 사용하여 원격 뷰어에서 그래픽 콘솔 보기

웹 콘솔 인터페이스를 사용하면 선택한 VM(가상 머신)의 그래픽 콘솔을 원격 뷰어(예: Virt Viewer)에 표시할 수 있습니다.

웹 콘솔 내에서 Virt Viewer를 시작할 수 있습니다. 기타 VNC 및 SPICE 원격 뷰어는 수동으로 시작할 수 있습니다.

사전 요구 사항

- 웹 콘솔 VM 플러그인이 시스템에 설치되어 있습니다.

- 호스트와 VM이 모두 그래픽 인터페이스를 지원하는지 확인합니다.

Virt Viewer에서 그래픽 콘솔을 보려면 웹 콘솔이 연결된 시스템에 Virt Viewer를 설치해야 합니다.

Launch remote viewer(원격 뷰어 시작)를 클릭합니다.

virt 뷰어

.vv, 파일이 다운로드됩니다.- 파일을 열어 Virt Viewer를 시작합니다.

원격 뷰어는 대부분의 운영 체제에서 사용할 수 있습니다. 그러나 일부 브라우저 확장 및 플러그인에서는 웹 콘솔에서 Virt Viewer를 열 수 없습니다.

절차

Virtual Machines (가상 시스템) 인터페이스에서 볼 그래픽 콘솔이 있는 VM을 클릭합니다.

VM에 대한 개요 및 콘솔 섹션이 포함된 새 페이지가 열립니다.

콘솔 드롭다운 메뉴에서 Desktop Viewer (데스크탑 뷰어)를 선택합니다.

원격 뷰어 시작을 클릭합니다.

그래픽 콘솔이 Virt Viewer(가상 뷰어)에서 열립니다.

실제 시스템과 상호 작용하는 것과 동일한 방식으로 마우스 및 키보드를 사용하여 VM 콘솔과 상호 작용할 수 있습니다. VM 콘솔의 디스플레이는 VM에서 수행 중인 활동을 반영합니다.

웹 콘솔이 실행 중인 서버는 Ctrl+Alt+Del 과 같은 특정 키 조합을 가로채어 VM으로 전송되지 않도록 할 수 있습니다.

이러한 키 조합을 보내려면 키 보내기 메뉴를 클릭하고 전송할 키 시퀀스를 선택합니다.

예를 들어 Ctrl+Alt+Del 조합이 VM에 전송하려면 Send 키 메뉴를 클릭하고 Ctrl+Alt+Del 메뉴 항목을 선택합니다.

문제 해결

- 그래픽 콘솔을 클릭해도 효과가 없으면 콘솔을 전체 화면으로 확장하십시오. 이는 마우스 커서 오프셋의 알려진 문제입니다.

웹 콘솔에서 원격 뷰어를 시작하지 않거나 최적이 아닌 경우 다음 프로토콜을 사용하여 뷰어 애플리케이션과 수동으로 연결할 수 있습니다.

-

주소 - 기본 주소는

127.0.0.1입니다./etc/libvirt/qemu.conf에서vnc매개변수를 수정하여 호스트의 IP 주소로 변경할 수 있습니다._listen매개변수 또는 spice_listen - SPICE 포트 - 5900

- VNC 포트 - 5901

-

주소 - 기본 주소는

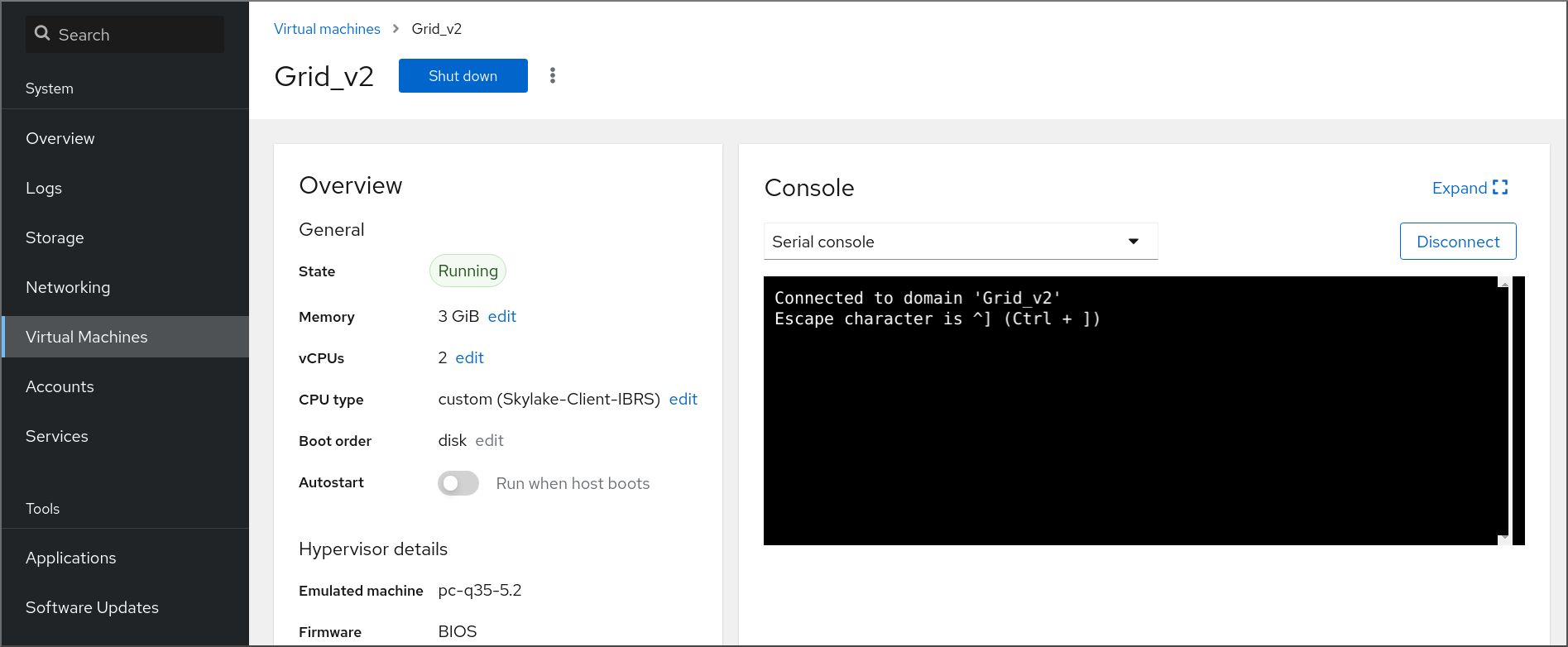

2.4.1.3. 웹 콘솔에서 가상 머신 직렬 콘솔 보기

RHEL 8 웹 콘솔에서 선택한 VM(가상 머신)의 직렬 콘솔을 볼 수 있습니다. 이 기능은 호스트 시스템 또는 VM이 그래픽 인터페이스로 구성되지 않은 경우 유용합니다.

직렬 콘솔에 대한 자세한 내용은 가상 머신 직렬 콘솔 열기를 참조하십시오.

사전 요구 사항

- 웹 콘솔 VM 플러그인이 시스템에 설치되어 있습니다.

절차

Virtual Machines (가상 시스템) 창에서 볼 직렬 콘솔이 있는 VM을 클릭합니다.

VM에 대한 개요 및 콘솔 섹션이 포함된 새 페이지가 열립니다.

콘솔 드롭다운 메뉴에서 직렬 콘솔을 선택합니다.

그래픽 콘솔이 웹 인터페이스에 나타납니다.

VM에서 직렬 콘솔을 연결을 끊고 다시 연결할 수 있습니다.

- VM에서 직렬 콘솔을 연결 해제하려면 Disconnect(연결 끊기 )를 클릭합니다.

- 직렬 콘솔을 VM에 다시 연결하려면 다시 연결을 클릭합니다.

2.4.2. Virt Viewer를 사용하여 가상 머신 그래픽 콘솔 열기

KVM VM(가상 시스템)의 그래픽 콘솔에 연결하고 Virt Viewer 데스크탑 애플리케이션에서 열려면 아래 절차를 따르십시오.

사전 요구 사항

- 시스템과 연결 중인 VM은 그래픽 디스플레이를 지원해야 합니다.

- 대상 VM이 원격 호스트에 있는 경우 호스트에 대한 연결 및 루트 액세스 권한이 필요합니다.

- 선택 사항: 대상 VM이 원격 호스트에 있는 경우 원격 호스트에 보다 편리하게 액세스할 수 있도록 libvirt 및 SSH를 설정합니다.

절차

로컬 VM에 연결하려면 다음 명령을 사용하고 guest-name 을 연결하려는 VM의 이름으로 바꿉니다.

# virt-viewer guest-name원격 VM에 연결하려면 SSH 프로토콜과 함께

virt-viewer명령을 사용합니다. 예를 들어 다음 명령은 원격 시스템 192.0.2.1에 있는 guest-name 이라는 VM에 root로 연결합니다. 이 연결에는 192.0.2.1에 대한 루트 인증도 필요합니다.# virt-viewer --direct --connect qemu+ssh://root@192.0.2.1/system guest-name root@192.0.2.1's password:

검증

연결이 올바르게 작동하면 Virt Viewer (가상 뷰어) 창에 VM 디스플레이가 표시됩니다.

실제 시스템과 상호 작용하는 것과 동일한 방식으로 마우스 및 키보드를 사용하여 VM 콘솔과 상호 작용할 수 있습니다. VM 콘솔의 디스플레이는 VM에서 수행 중인 활동을 반영합니다.

문제 해결

- 그래픽 콘솔을 클릭해도 효과가 없으면 콘솔을 전체 화면으로 확장하십시오. 이는 마우스 커서 오프셋의 알려진 문제입니다.

추가 리소스

-

virt-viewerman 페이지 - 원격 가상화 호스트에 쉽게 액세스 가능

- 웹 콘솔을 사용하여 가상 머신과 상호 작용

2.4.3. SSH를 사용하여 가상 머신에 연결

SSH 연결 프로토콜을 사용하여 VM(가상 머신) 터미널과 상호 작용하려면 다음 절차를 따르십시오.

사전 요구 사항

- 대상 VM에 대한 네트워크 연결 및 루트 액세스 권한이 있어야 합니다.

- 대상 VM이 원격 호스트에 있는 경우 해당 호스트에 대한 연결 및 루트 액세스 권한도 있습니다.

VM 네트워크는

libvirt에서 생성된dnsmasq에 의해 IP 주소를 할당합니다. 예를 들어libvirtNAT 네트워크 의 경우입니다.특히 VM에서 다음 네트워크 구성 중 하나를 사용하는 경우 SSH를 사용하여 VM에 연결할 수 없습니다.

-

hostdev인터페이스 - 직접 인터페이스

- 브리지 상호 작용

-

libvirt-nss구성 요소는 VM의 호스트에 설치 및 활성화됩니다. 그렇지 않은 경우 다음을 수행합니다.libvirt-nss패키지를 설치합니다.# yum install libvirt-nss/etc/nsswitch.conf파일을 편집하고hosts행에libvirt_guest를 추가합니다.... passwd: compat shadow: compat group: compat hosts: files libvirt_guest dns ...

절차

원격 VM에 연결할 때 먼저 물리적 호스트에 SSH로 연결합니다. 다음 예제에서는 루트 자격 증명을 사용하여 호스트 시스템

192.0.2.1에 연결하는 방법을 보여줍니다.# ssh root@192.0.2.1 root@192.0.2.1's password: Last login: Mon Sep 24 12:05:36 2021 root~#VM의 이름 및 사용자 액세스 자격 증명을 사용하여 연결합니다. 예를 들어 다음은 루트 인증 정보를 사용하여

testguest1VM에 연결합니다.# ssh root@testguest1 root@testguest1's password: Last login: Wed Sep 12 12:05:36 2018 root~]#

문제 해결

VM 이름을 모르는 경우

virsh list --all명령을 사용하여 호스트에서 사용 가능한 모든 VM을 나열할 수 있습니다.# virsh list --all Id Name State ---------------------------------------------------- 2 testguest1 running - testguest2 shut off

추가 리소스

2.4.4. 가상 머신 직렬 콘솔 열기

virsh console 명령을 사용하면 VM(가상 머신)의 직렬 콘솔에 연결할 수 있습니다.

이 기능은 VM에서 유용합니다.

- VNC 또는 SPICE 프로토콜을 제공하지 않으므로 GUI 도구에 대한 비디오 표시를 제공하지 않습니다.

- 에는 네트워크 연결이 없으므로 SSH를 사용하여 와 상호 작용할 수 없습니다.

사전 요구 사항

VM에는 콘솔

type='pty'와 같이 직렬 콘솔장치가 구성되어 있어야 합니다. 확인하려면 다음을 수행하십시오.# virsh dumpxml vm-name | grep console <console type='pty' tty='/dev/pts/2'> </console>VM에는 커널 명령줄에 직렬 콘솔이 구성되어 있어야 합니다. 이를 확인하려면 VM의

cat /proc/cmdline명령 출력에 console=ttyS0 이 포함되어야 합니다. 예를 들면 다음과 같습니다.# cat /proc/cmdline BOOT_IMAGE=/vmlinuz-3.10.0-948.el7.x86_64 root=/dev/mapper/rhel-root ro console=tty0 console=ttyS0,9600n8 rd.lvm.lv=rhel/root rd.lvm.lv=rhel/swap rhgbVM에 직렬 콘솔이 제대로 설정되지 않은 경우 virsh 콘솔을 사용하여 VM에 연결하면 응답하지 않는 게스트 콘솔에 연결합니다. 그러나 Ctrl+] 바로 가기를 사용하여 응답하지 않는 콘솔을 종료할 수 있습니다.

VM에 직렬 콘솔을 설정하려면 다음을 수행합니다.

VM에서

console=ttyS0커널 옵션을 활성화합니다.# grubby --update-kernel=ALL --args="console=ttyS0"변경 사항이 적용되지 않을 수 있는 커널 옵션을 지웁니다.

# grub2-editenv - unset kernelopts- VM을 재부팅합니다.

절차

호스트 시스템에서

virsh console명령을 사용합니다. 다음 예제에서는 libvirt 드라이버가 안전한 콘솔 처리를 지원하는 경우 guest1 VM에 연결합니다.# virsh console guest1 --safe Connected to domain 'guest1' Escape character is ^] Subscription-name Kernel 3.10.0-948.el7.x86_64 on an x86_64 localhost login:

- 표준 명령줄 인터페이스와 동일한 방식으로 virsh 콘솔과 상호 작용할 수 있습니다.

추가 리소스

-

virshman 페이지

2.4.5. 원격 가상화 호스트에 대한 손쉬운 액세스 설정

libvirt 유틸리티를 사용하여 원격 호스트 시스템에서 VM을 관리하는 경우 -c qemu+ssh://root@hostname/system 구문을 사용하는 것이 좋습니다. 예를 들어 192.0.2.1 호스트에서 root로 virsh list 명령을 사용하려면 다음을 수행합니다.

# virsh -c qemu+ssh://root@192.0.2.1/system list

root@192.0.2.1's password:

Id Name State

---------------------------------

1 remote-guest running그러나 SSH 및 libvirt 구성을 수정하여 연결 세부 정보를 완전히 지정해야 할 필요성을 제거할 수 있습니다. 예를 들면 다음과 같습니다.

# virsh -c remote-host list

root@192.0.2.1's password:

Id Name State

---------------------------------

1 remote-guest running이 개선 사항을 사용하려면 아래 지침을 따르십시오.

절차

다음 세부 정보를 사용하여

~/.ssh/config파일을 편집합니다. 여기서 host-alias 는 특정 원격 호스트와 관련된 단축된 이름 및 root@192.0.2.1의 별칭이며 hosturl 은 호스트의 URL 주소입니다.# vi ~/.ssh/config Host example-host-alias User root Hostname 192.0.2.1

다음 세부 정보를 사용하여

/etc/libvirt/libvirt.conf파일을 편집합니다. example-qemu-host-alias 는 QEMU 및 libvirt 유틸리티가qemu+ssh://192.0.2.1/system에 대해 원하는 호스트 example-host-alias 와 연결하는 호스트 별칭입니다.# vi /etc/libvirt/libvirt.conf uri_aliases = [ "example-qemu-host-alias=qemu+ssh://example-host-alias/system", ]

검증

추가된

-c qemu-host-alias매개변수가 있는 로컬 시스템에서 libvirt 기반 유틸리티를 사용하여 원격 VM을 관리할 수 있는지 확인합니다. 이렇게 하면 원격 호스트에서 SSH를 통해 자동으로 명령을 수행합니다.예를 들어 다음 항목이 192.0.2.1 원격 호스트의 VM을 나열하고, 에 대한 연결이 이전 단계에서 example-qemu-host-alias 로 설정되어 있는지 확인합니다.

# virsh -c example-qemu-host-alias list root@192.0.2.1's password: Id Name State ---------------------------------------- 1 example-remote-guest running참고virsh외에-c(또는--connect) 옵션과 위에서 설명한 원격 호스트 액세스 구성은 다음 유틸리티에서 사용할 수 있습니다.

다음 단계

단일 원격 호스트에서만 libvirt 유틸리티를 사용하려는 경우 특정 연결을 libvirt 기반 유틸리티의 기본 대상으로 설정할 수도 있습니다. 그러나 로컬 호스트 또는 다른 원격 호스트에서 VM을 관리하려는 경우에는 권장되지 않습니다.

/etc/libvirt/libvirt.conf파일을 편집하고uri_default매개변수 값을 기본 libvirt 대상으로 example-qemu-host-alias 로 설정할 수 있습니다.# These can be used in cases when no URI is supplied by the application # (@uri_default also prevents probing of the hypervisor driver). # uri_default = "example-qemu-host-alias"

결과적으로 모든 libvirt 기반 명령이 지정된 원격 호스트에서 자동으로 수행됩니다.

$ virsh list root@192.0.2.1's password: Id Name State --------------------------------- 1 example-remote-guest running원격 호스트에 연결할 때 원격 시스템에 root 암호를 제공하지 않도록 할 수 있습니다. 이 작업을 수행하려면 다음 방법 중 하나 이상을 사용하십시오.

- 원격 호스트에 대한 키 기반 SSH 액세스 설정

- 원격 시스템에 연결하기 위해 SSH 연결 멀티플렉싱 사용

- Identity Management의 Kerberos 인증

-

-c(또는--connect) 옵션을 사용하여 원격 호스트에서virt-install,virt-viewer,virsh및virt-manager명령을 실행할 수 있습니다.

2.5. 가상 머신 종료

RHEL 8에서 호스팅되는 실행 중인 가상 머신 을 종료하려면 명령줄 인터페이스 또는 웹 콘솔 GUI를 사용합니다.

2.5.1. 명령줄 인터페이스를 사용하여 가상 머신 종료

응답하는 VM(가상 머신)을 종료하려면 다음 중 하나를 수행합니다.

- 게스트에 연결된 동안 게스트 OS에 적합한 shutdown 명령을 사용합니다.

호스트에서

virsh shutdown명령을 사용합니다.VM이 로컬 호스트에 있는 경우:

# virsh shutdown demo-guest1 Domain 'demo-guest1' is being shutdownVM이 원격 호스트에 있는 경우 이 예제에서는 192.0.2.1입니다.

# virsh -c qemu+ssh://root@192.0.2.1/system shutdown demo-guest1 root@192.0.2.1's password: Domain 'demo-guest1' is being shutdown

VM이 종료되도록 하려면 예를 들어 응답하지 않는 경우 호스트에서 virsh destroy 명령을 사용합니다.

# virsh destroy demo-guest1

Domain 'demo-guest1' destroyed

virsh destroy 명령은 실제로 VM 구성 또는 디스크 이미지를 삭제하거나 제거하지 않습니다. 실제 시스템에서 전원을 가져오는 것과 마찬가지로 VM의 실행 중인 VM 인스턴스만 종료합니다. 따라서 드문 경우에서 virsh destroy 는 VM의 파일 시스템이 손상될 수 있으므로 다른 모든 종료 방법이 실패한 경우에만 이 명령을 사용하는 것이 좋습니다.

2.5.2. 웹 콘솔을 사용하여 가상 머신 종료 및 재시작

RHEL 8 웹 콘솔을 사용하여 실행 중인 가상 머신을 종료 하거나 다시 시작할 수 있습니다. 또한 마스킹할 수 없는 인터럽트를 응답하지 않는 가상 머신으로 보낼 수도 있습니다.

2.5.2.1. 웹 콘솔에서 가상 머신 종료

VM(가상 머신)이 실행 중 상태인 경우 RHEL 8 웹 콘솔을 사용하여 종료할 수 있습니다.

사전 요구 사항

- 웹 콘솔 VM 플러그인이 시스템에 설치되어 있습니다.

절차

- Virtual Machines (가상 시스템) 인터페이스에서 종료할 VM의 행을 찾습니다.

행 오른쪽에서 Shut Down 을 클릭합니다.

VM이 종료됩니다.

문제 해결

- VM이 종료되지 않으면 Shut Down(시스템 종료) 버튼 옆에 있는 Menu(메뉴) 버튼을 클릭하고 Force Shut Down (강제 종료)을 선택합니다.

- 응답하지 않는 VM을 종료하려면 마스킹 불가능한 인터럽트를 보낼 수도 있습니다.

2.5.2.2. 웹 콘솔을 사용하여 가상 머신 재시작

VM(가상 머신)이 실행 중 상태인 경우 RHEL 8 웹 콘솔을 사용하여 다시 시작할 수 있습니다.

사전 요구 사항

- 웹 콘솔 VM 플러그인이 시스템에 설치되어 있습니다.

절차

- 가상 머신 인터페이스에서 재시작할 VM 행을 찾습니다.

행 오른쪽에서 메뉴 버튼을 클릭합니다 .

작업 드롭다운 메뉴가 나타납니다.

드롭다운 메뉴에서 재부팅 을 클릭합니다.

VM이 종료되고 다시 시작됩니다.

문제 해결

- VM이 재시작되지 않으면 재부팅 버튼 옆에 있는 메뉴 버튼을 클릭하고 강제 재부팅 을 선택합니다.

- 응답하지 않는 VM을 종료하려면 마스킹 불가능한 인터럽트를 보낼 수도 있습니다.

2.5.2.3. 웹 콘솔을 사용하여 마스킹할 수 없는 인터럽트를 VM에 전송

마스크할 수 없는 인터럽트(NMI)를 전송하면 VM(가상 시스템)이 응답하거나 종료될 수 있습니다. 예를 들어 표준 입력에 응답하지 않는 VM에 Ctrl+Alt+Del NMI를 보낼 수 있습니다.

사전 요구 사항

- 웹 콘솔 VM 플러그인이 시스템에 설치되어 있습니다.

절차

- 가상 머신 인터페이스에서 NMI를 보낼 VM 행을 찾습니다.

행 오른쪽에서 메뉴 버튼을 클릭합니다 .

작업 드롭다운 메뉴가 나타납니다.

드롭다운 메뉴에서 마스크가 없는 인터럽트 보내기 를 클릭합니다.

NMI가 VM으로 전송됩니다.

2.6. 가상 머신 삭제

RHEL 8에서 가상 머신을 삭제하려면 명령줄 인터페이스 또는 웹 콘솔 GUI 를 사용합니다.

2.6.1. 명령줄 인터페이스를 사용하여 가상 머신 삭제

VM(가상 머신)을 삭제하려면 명령줄을 사용하여 호스트에서 XML 구성 및 관련 스토리지 파일을 제거할 수 있습니다. 다음 절차를 따르십시오.

사전 요구 사항

- VM에서 중요한 데이터를 백업합니다.

- VM을 종료합니다.

- 다른 VM이 동일한 관련 스토리지를 사용하지 않는지 확인합니다.

절차

virsh undefine유틸리티를 사용합니다.예를 들어 다음 명령은 guest1 VM, 관련 스토리지 볼륨 및 비발성 RAM(있는 경우)을 제거합니다.

# virsh undefine guest1 --remove-all-storage --nvram Domain 'guest1' has been undefined Volume 'vda'(/home/images/guest1.qcow2) removed.

추가 리소스

-

virsh undefine --help명령 -

virshman 페이지

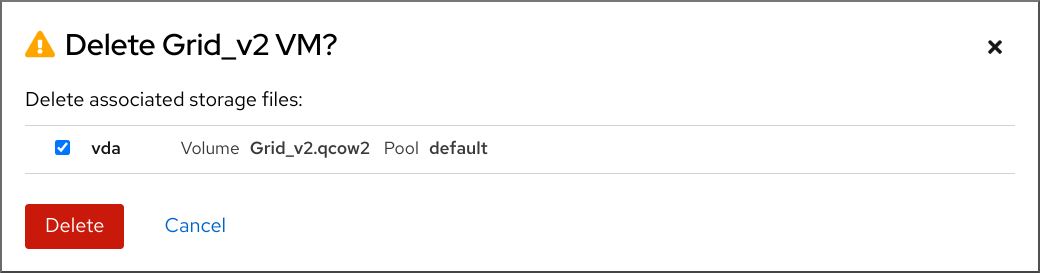

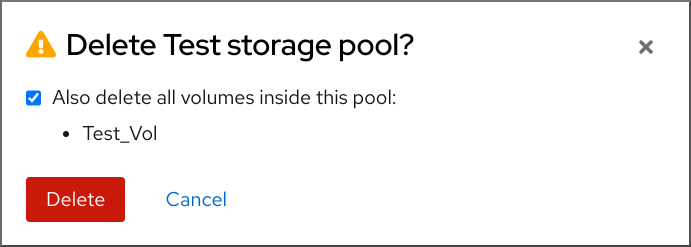

2.6.2. 웹 콘솔을 사용하여 가상 머신 삭제

RHEL 8 웹 콘솔이 연결된 호스트에서 VM(가상 머신) 및 관련 스토리지 파일을 삭제하려면 다음 절차를 따르십시오.

사전 요구 사항

- 웹 콘솔 VM 플러그인이 시스템에 설치되어 있습니다.

- VM에서 중요한 데이터를 백업합니다.

- 다른 VM이 동일한 연결된 스토리지를 사용하지 않는지 확인합니다.

- 선택 사항: VM을 종료합니다.

절차

Virtual Machines(가상 시스템 ) 인터페이스에서 삭제할 VM 의 Menu(메뉴) 버튼 QCOW를 클릭합니다.

다양한 VM 작업에 대한 컨트롤이 포함된 드롭다운 메뉴가 나타납니다.

삭제를 클릭합니다.

확인 대화 상자가 나타납니다.

- 선택 사항: VM과 연결된 스토리지 파일 전체를 삭제하려면 삭제할 스토리지 파일 옆에 있는 확인란을 선택합니다.

삭제를 클릭합니다.

VM 및 선택한 스토리지 파일이 삭제됩니다.

3장. IBM POWER에서 가상화 시작하기

IBM POWER8 또는 POWER9 하드웨어에서 RHEL 8을 사용할 때 KVM 가상화를 사용할 수 있습니다. 그러나 시스템에서 KVM 하이퍼바이저를 활성화하려면 AMD64 및 Intel64 아키텍처의 가상화와 비교하여 추가 단계가 필요합니다. 특정 RHEL 8 가상화 기능은 IBM POWER에 대해 다르거나 제한된 기능도 있습니다.

다음 섹션의 정보 외에도 IBM POWER의 가상화를 사용하는 것은 AMD64 및 Intel 64와 동일하게 작동합니다. 따라서 IBM POWER에서 가상화를 사용할 때 자세한 내용은 다른 RHEL 8 가상화 설명서를 참조하십시오.

3.1. IBM POWER에서 가상화 활성화

RHEL 8을 실행하는 IBM POWER8 또는 IBM POWER9 시스템에 KVM 하이퍼바이저를 설정하고 VM(가상 시스템)을 생성하려면 아래 지침을 따르십시오.

사전 요구 사항

- RHEL 8은 호스트 시스템에 설치 및 등록되어 있습니다.

사용 가능한 최소 시스템 리소스는 다음과 같습니다.

- 호스트용 디스크 여유 공간이 6GB, 의도한 각 VM에 대해 다른 6GB가 추가됩니다.

- 호스트용 2GB RAM 및 각 VM에 대해 다른 2GB.

- 호스트의 CPU 4개. 일반적으로 VM은 할당된 단일 vCPU로 실행할 수 있지만, 높은 로드 중에 VM이 응답하지 않도록 VM당 2개 이상의 vCPU를 할당하는 것이 좋습니다.

CPU 시스템 유형은 IBM POWER 가상화를 지원해야 합니다.

이를 확인하려면

/proc/cpuinfo파일에서 플랫폼 정보를 쿼리합니다.# grep ^platform /proc/cpuinfo/ platform : PowerNV이 명령의 출력에

PowerNV항목이 포함된 경우 PowerNV 시스템 유형을 실행하고 IBM POWER에서 가상화를 사용할 수 있습니다.

절차

KVM-HV 커널 모듈 로드

# modprobe kvm_hvKVM 커널 모듈이 로드되었는지 확인합니다.

# lsmod | grep kvmKVM이 성공적으로 로드되면 이 명령의 출력에

kvm_hv가 포함됩니다.가상화 모듈에 패키지를 설치합니다.

# yum module install virtvirt-install패키지를 설치합니다.# yum install virt-installlibvirtd서비스를 시작합니다.# systemctl start libvirtd

검증

시스템이 가상화 호스트가 될 준비가 되었는지 확인합니다.

# virt-host-validate [...] QEMU: Checking if device /dev/vhost-net exists : PASS QEMU: Checking if device /dev/net/tun exists : PASS QEMU: Checking for cgroup 'memory' controller support : PASS QEMU: Checking for cgroup 'memory' controller mount-point : PASS [...] QEMU: Checking for cgroup 'blkio' controller support : PASS QEMU: Checking for cgroup 'blkio' controller mount-point : PASS QEMU: Checking if IOMMU is enabled by kernel : PASS모든 virt-host-validate 검사에서

PASS값을 반환하면 시스템에서 VM을 생성할 준비가 됩니다.검사 중

실패값을 반환하는 경우 표시된 지침에 따라 문제를 해결합니다.검사 중 하나라도

WARN값을 반환하는 경우 표시된 지침을 따라 가상화 기능을 개선하는 것이 좋습니다.

문제 해결

호스트 CPU에서 KVM 가상화를 지원하지 않는 경우 virt-host-validate 는 다음 출력을 생성합니다.

QEMU: Checking for hardware virtualization: FAIL (Only emulated CPUs are available, performance will be significantly limited)

그러나 이러한 호스트 시스템의 VM은 성능 문제가 아닌 부팅에 실패합니다.

이 문제를 해결하려면 VM의 XML 구성에서 &

lt;domain type> 값을qemu로 변경할 수 있습니다. 그러나 Red Hat은qemu도메인 유형을 사용하는 VM을 지원하지 않으며 프로덕션 환경에서는 사용하지 않는 것이 좋습니다.

3.2. IBM POWER의 가상화가 AMD64 및 Intel 64와 다른 방법

IBM POWER 시스템의 RHEL 8의 KVM 가상화는 AMD64 및 Intel 64 시스템의 KVM과 크게 다릅니다.

- 메모리 요구 사항

- IBM POWER의 VM은 더 많은 메모리를 사용합니다. 따라서 IBM POWER 호스트의 VM(가상 시스템)에 권장되는 최소 메모리 할당은 2GB RAM입니다.

- 표시 프로토콜

SPICE 프로토콜은 IBM POWER 시스템에서 지원되지 않습니다. VM의 그래픽 출력을 표시하려면

VNC프로토콜을 사용합니다. 또한 다음 가상 그래픽 카드 장치만 지원됩니다.-

cd--vga std모드에서만 지원되며-vga cirrus모드에서는 지원되지 않습니다. -

virtio-vga -

virtio-gpu

-

- SMBIOS

- SMBIOS 구성을 사용할 수 없습니다.

- 메모리 할당 오류

POWER8 VM(호환 모드 VM 포함)은 다음과 유사한 오류로 인해 실패할 수 있습니다.

qemu-kvm: Failed to allocate KVM HPT of order 33 (try smaller maxmem?): Cannot allocate memory

이는 RHEL 7.3 이전과 게스트 OS 이전의 VM에서 발생할 가능성이 훨씬 더 높습니다.

문제를 해결하려면 호스트의 커널 명령줄에

kvm_cma_resv_ratio= 메모리를 추가하여 게스트의 해시된 페이지 테이블(HPT)에 사용할 수 있는 CMA메모리풀을 늘립니다. 여기서 메모리 는 CMA 풀에 예약해야 하는 호스트 메모리의 백분율입니다(기본값: 5).- Huge Page

THP(Transparent Huge Page)는 IBM POWER8 VM에서 주목할 만한 성능 이점을 제공하지 않습니다. 그러나 IBM POWER9 VM은 THP를 예상대로 활용할 수 있습니다.

또한 IBM POWER8 시스템의 정적 대규모 페이지 크기는 AMD64, Intel 64 및 IBM POWER9의 경우 2MiB 및 1GiB와 달리 16MiB 및 16GiB입니다. 결과적으로 IBM POWER8 호스트에서 IBM POWER9 호스트로 정적 대규모 페이지로 구성된 VM을 마이그레이션하려면 먼저 VM에서 1GiB 대규모 페이지를 설정해야 합니다.

- kvm-clock

-

kvm-clock서비스는 IBM POWER9의 VM의 시간 관리를 위해 구성하지 않아도 됩니다. - pvpanic

IBM POWER9 시스템은

pvpanic장치를 지원하지 않습니다. 그러나 이 아키텍처에서 기본적으로 동등한 기능을 사용할 수 있으며 활성화됩니다. VM에서 활성화하려면유지값과 함께<on_crash>XML 구성 요소를 사용합니다.또한 VM이 IBM POWER 시스템에서 부팅되지 않을 수 있으므로

<devices>섹션에서 <panic> 요소를제거해야 합니다.- 단일 스레드 호스트

- IBM POWER8 시스템에서 VM을 지원하려면 호스트 시스템을 단일 스레드 모드로 실행해야 합니다. qemu-kvm 패키지가 설치된 경우 자동으로 구성됩니다. 그러나 단일 스레드 호스트에서 실행되는 VM은 여전히 여러 스레드를 사용할 수 있습니다.

- 주변 장치

IBM POWER 시스템에서 AMD64 및 Intel 64 시스템에서 지원되는 여러 주변 장치가 지원되지 않거나 다른 장치가 대체로 지원됩니다.

-

i¢3420및xio3130-downstream을 포함한 PCI-E 계층 구조에 사용되는 장치는 지원되지 않습니다. 이 기능은spapr-pci-host-bridge장치에서 제공하는 여러 독립 PCI 루트 브리지로 교체됩니다. - UHCI 및 EHCI PCI 컨트롤러는 지원되지 않습니다. 대신 OHCI 및 XHCI 컨트롤러를 사용합니다.

-

가상 IDE CD-ROM(

ide-cd) 및 가상 IDE 디스크(ide-hd)를 포함하는 IDE 장치는 지원되지 않습니다. 대신virtio-scsi및virtio-blk장치를 사용합니다. -

에뮬레이트된 PCI NIC(

rtl8139)는 지원되지 않습니다. 대신virtio-net장치를 사용합니다. -

intel-hda,hda-output,AC97을 포함한 사운드 장치는 지원되지 않습니다. -

usb-redir 및를 포함한 USB 리디렉션 장치는 지원되지 않습니다.usb-tablet

-

- v2v 및 p2v

-

virt-v2v및virt-p2v유틸리티는 AMD64 및 Intel 64 아키텍처에서만 지원되며 IBM POWER에서는 제공되지 않습니다.

추가 소스

- Red Hat에서 지원하는 시스템 아키텍처에서 지원되는 가상화 기능 및 지원되지 않는 가상화 기능을 비교하려면 RHEL 8의 가상화 기능 지원에 대한 개요 를 참조하십시오.

4장. IBM Z에서 가상화 시작하기

IBM Z 하드웨어에서 RHEL 8을 사용할 때 KVM 가상화를 사용할 수 있습니다. 그러나 시스템에서 KVM 하이퍼바이저를 활성화하려면 AMD64 및 Intel 64 아키텍처의 가상화와 비교하여 추가 단계가 필요합니다. 특정 RHEL 8 가상화 기능에는 IBM Z에서도 다르거나 제한된 기능이 있습니다.

다음 섹션의 정보 외에도 IBM Z의 가상화를 사용하는 것은 AMD64 및 Intel 64와 동일하게 작동합니다. 따라서 IBM Z에서 가상화를 사용할 때 자세한 내용은 다른 RHEL 8 가상화 설명서를 참조하십시오.

z/VM OS에서 KVM을 실행하는 것은 지원되지 않습니다.

4.1. IBM Z에서 가상화 활성화

RHEL 8을 실행하는 IBM Z 시스템에 KVM 하이퍼바이저를 설정하고 VM(가상 머신)을 생성하려면 다음 지침을 따르십시오.

사전 요구 사항

RHEL 8.6 이상이 호스트 머신에 설치되고 등록됩니다.

중요RHEL 8.5 또는 이전 버전을 사용하여 IBM Z 머신에서 가상화를 이미 활성화한 경우 대신 가상화 모듈을 재구성하고 시스템을 업데이트해야 합니다. 자세한 내용은 IBM Z의 가상화가 AMD64 및 Intel 64와 어떻게 다른지 참조하십시오.

사용 가능한 최소 시스템 리소스는 다음과 같습니다.

- 호스트용 디스크 여유 공간이 6GB, 의도한 각 VM에 대해 다른 6GB가 추가됩니다.

- 호스트용 2GB RAM 및 각 VM에 대해 다른 2GB.

- 호스트의 CPU 4개. 일반적으로 VM은 할당된 단일 vCPU로 실행할 수 있지만, 높은 로드 중에 VM이 응답하지 않도록 VM당 2개 이상의 vCPU를 할당하는 것이 좋습니다.

- IBM Z 호스트 시스템은 z13 CPU 이상을 사용하고 있습니다.

RHEL 8은 LVR(논리 파티션)에 설치됩니다. 또한 LPAR은 시작 인터프리티브 실행 (SIE) 가상화 기능을 지원합니다.

이를

확인하려면/proc/cpuinfo파일에서 를 검색합니다.# grep sie /proc/cpuinfo features : esan3 zarch stfle msa ldisp eimm dfp edat etf3eh highgprs te sie

절차

KVM 커널 모듈을 로드합니다.

# modprobe kvmKVM 커널 모듈이 로드되었는지 확인합니다.

# lsmod | grep kvmKVM이 성공적으로 로드되면 이 명령의 출력에

kvm이 포함됩니다.virt:rhel/common모듈에 패키지를 설치합니다.# yum module install virt:rhel/common가상화 서비스를 시작합니다.

# for drv in qemu network nodedev nwfilter secret storage interface; do systemctl start virt${drv}d{,-ro,-admin}.socket; done

검증

시스템이 가상화 호스트로 준비되었는지 확인합니다.

# virt-host-validate [...] QEMU: Checking if device /dev/kvm is accessible : PASS QEMU: Checking if device /dev/vhost-net exists : PASS QEMU: Checking if device /dev/net/tun exists : PASS QEMU: Checking for cgroup 'memory' controller support : PASS QEMU: Checking for cgroup 'memory' controller mount-point : PASS [...]모든 virt-host-validate 검사에서

PASS값을 반환하면 시스템에서 VM을 생성할 준비가 됩니다.검사 중

실패값을 반환하는 경우 표시된 지침에 따라 문제를 해결합니다.검사 중 하나라도

WARN값을 반환하는 경우 표시된 지침을 따라 가상화 기능을 개선하는 것이 좋습니다.

문제 해결

호스트 CPU에서 KVM 가상화를 지원하지 않는 경우 virt-host-validate 는 다음 출력을 생성합니다.

QEMU: Checking for hardware virtualization: FAIL (Only emulated CPUs are available, performance will be significantly limited)

그러나 이러한 호스트 시스템의 VM은 성능 문제가 아닌 부팅에 실패합니다.

이 문제를 해결하려면 VM의 XML 구성에서 &

lt;domain type> 값을qemu로 변경할 수 있습니다. 그러나 Red Hat은qemu도메인 유형을 사용하는 VM을 지원하지 않으며 프로덕션 환경에서는 사용하지 않는 것이 좋습니다.

4.2. IBM Z의 가상화 업데이트 RHEL 8.5에서 RHEL 8.6 이상으로

RHEL 8.6 이전의 IBM Z 하드웨어에 RHEL 8을 설치하는 경우 RHEL 8의 기본 RPM 스트림과는 별도로 AV 스트림에서 가상화 RPM을 가져와야 했습니다. RHEL 8.6부터 이전에는 AV 스트림에서 사용 가능한 가상화 RPM은 기본 RHEL 스트림에서만 사용할 수 있습니다. 또한 RHEL 8의 향후 마이너 릴리스에서 AV 스트림이 중단될 예정입니다. 따라서 AV 스트림을 사용하는 것은 더 이상 권장되지 않습니다.

아래 지침에 따라 AV 스트림을 비활성화하고 RHEL 8.6 이상 버전에서 사용 가능한 가상화 RPM에 대한 액세스를 활성화합니다.

사전 요구 사항

virt:av모듈이 설치된 IBM Z에서 RHEL 8.5를 사용하고 있습니다. 이 경우인지 확인하려면 다음을 수행합니다.# hostnamectl | grep "Operating System" Operating System: Red Hat Enterprise Linux 8.5 (Ootpa) # yum module list --installed [...] Advanced Virtualization for RHEL 8 IBM Z Systems (RPMs) Name Stream Profiles Summary virt av [e] common [i] Virtualization module

절차

virt:av모듈을 비활성화합니다.# yum disable virt:av시스템에 이미 포함된 기존 가상화 패키지 및 모듈을 제거합니다.

# yum module reset virt -y패키지를 최신 RHEL 버전으로 업그레이드합니다.

# yum update이렇게 하면 시스템에서

virt:rhel모듈도 자동으로 활성화됩니다.

검증

시스템의

virt모듈이rhel스트림에서 제공되는지 확인합니다.# yum module info virt Name : virt Stream : rhel [d][e][a] Version : 8050020211203195115 [...]

4.3. IBM Z의 가상화가 AMD64 및 Intel 64와 어떻게 다른지

IBM Z 시스템의 RHEL 8에서 KVM 가상화는 AMD64 및 Intel 64 시스템의 KVM과 다릅니다.

- PCI 및 USB 장치

가상 PCI 및 USB 장치는 IBM Z에서 지원되지 않습니다. 또한

virtio-*-pci장치가 지원되지 않으며virtio-*-ccw장치를 대신 사용해야 합니다. 예를 들어virtio-net-를 사용합니다.pci 대신 virtio-net-ccwPCI 패스스루라고도 하는 PCI 장치의 직접 첨부가 지원됩니다.

- 지원되는 게스트 운영 체제

- Red Hat은 RHEL 7, 8 또는 9를 게스트 운영 체제로 사용하는 경우에만 IBM Z에서 호스팅되는 VM을 지원합니다.

- 장치 부팅 순서

IBM Z는

<boot dev='장치'>XML 구성 요소를 지원하지 않습니다. 장치 부팅 순서를 정의하려면 XML의<요소를 사용합니다.devices> 섹션에 <boot order='번호'>또한 <boot> 요소에서 architecture-specific

loadparm속성을 사용하여 필요한부팅 항목을선택할 수 있습니다. 예를 들어 다음에서는 부팅 순서에서 먼저 디스크를 사용해야 하며 해당 디스크에서 Linux 배포를 사용할 수 있는 경우 두 번째 부팅 항목을 선택합니다.<disk type='file' device='disk'> <driver name='qemu' type='qcow2'/> <source file='/path/to/qcow2'/> <target dev='vda' bus='virtio'/> <address type='ccw' cssid='0xfe' ssid='0x0' devno='0x0000'/> <boot order='1' loadparm='2'/> </disk>

참고부팅 순서

관리에 <boot order='number'>를 사용하면 AMD64 및 Intel 64 호스트에서도 권장됩니다.- 메모리 핫 플러그

- IBM Z에서는 실행 중인 VM에 메모리를 추가할 수 없습니다. 실행 중인 VM(메모리핫 언플러그)에서 메모리를제거하는 것은 IBM Z에서도 사용할 수 없으며 AMD64 및 Intel 64에서도 사용할 수 없습니다.

- NUMA 토폴로지

-

CPU의 NUMA(Non-Uniform Memory Access) 토폴로지는 IBM Z의

libvirt에서 지원되지 않습니다. 따라서 NUMA를 사용하여 vCPU 성능 튜닝은 이러한 시스템에서 불가능합니다. - vfio-ap

- IBM Z 호스트의 VM은 다른 아키텍처에서 지원되지 않는 vfio-ap 암호화 장치 패스스루를 사용할 수 있습니다.

- vfio-ccw

- IBM Z 호스트의 VM은 다른 아키텍처에서 지원되지 않는 vfio-ccw 디스크 장치 패스스루를 사용할 수 있습니다.

- SMBIOS

- IBM Z에서는 SMBIOS 구성을 사용할 수 없습니다.

- 워치독 장치

IBM Z 호스트에서 VM에서 워치독 장치를 사용하는 경우

diag288모델을 사용합니다. 예를 들면 다음과 같습니다.<devices> <watchdog model='diag288' action='poweroff'/> </devices>

- kvm-clock

-

kvm-clock서비스는 AMD64 및 Intel 64 시스템에 고유하며 IBM Z의 VM 시간 관리를 위해 구성하지 않아도 됩니다. - v2v 및 p2v

-

virt-v2v및virt-p2v유틸리티는 AMD64 및 Intel 64 아키텍처에서만 지원되며 IBM Z에서는 제공되지 않습니다. - 중첩된 가상화

- 중첩된 VM을 생성하려면 AMD64 및 Intel 64와 IBM Z의 다른 설정이 필요합니다. 자세한 내용은 중첩된 가상 머신 생성을 참조하십시오.

- 이전 릴리스에서는 그래픽 출력이 없습니다

-

호스트에서 RHEL 8.3 또는 이전 마이너 버전을 사용하는 경우 VNC 프로토콜을 사용하여 VM에 연결할 때 VM 그래픽 출력을 표시할 수 없습니다. 이는 IBM Z의 이전 RHEL 버전에서

gnome-desktop유틸리티가 지원되지 않기 때문입니다. 또한 SPICE 디스플레이 프로토콜은 IBM Z에서 작동하지 않기 때문입니다. - 마이그레이션

이후 호스트 모델로 마이그레이션(예: IBM z14에서 z15로 마이그레이션)하거나 하이퍼바이저를 업데이트하려면

host-modelCPU 모드를 사용합니다. 일반적으로 마이그레이션 안전이 아니므로host-passthrough및최대CPU 모드는 권장되지 않습니다.사용자 정의CPU 모드에서 명시적 CPU 모델을 지정하려면 다음 지침을 따르십시오.-

-base로 끝나는 CPU 모델을 사용하지 마십시오. -

qemu,max또는hostCPU 모델을 사용하지 마십시오.

이전 호스트 모델(예: z15에서 z14) 또는 이전 버전의 QEMU, KVM 또는 RHEL 커널로 마이그레이션하려면 끝에

-base없이 가장 오래된 호스트 모델의 CPU 유형을 사용합니다.-

소스 호스트와 대상 호스트가 모두 실행 중인 경우 대상 호스트에서

virsh hypervisor-cpu-baseline명령을 사용하여 적절한 CPU 모델을 가져올 수 있습니다. 자세한 내용은 가상 머신 마이그레이션에 대한 호스트 CPU 호환성 확인을 참조하십시오. - RHEL 8에서 지원되는 머신 유형에 대한 자세한 내용은 RHEL 8 가상화의 권장 기능을 참조하십시오.

-

- PXE 설치 및 부팅

PXE를 사용하여 IBM Z에서 VM을 실행하는 경우

pxelinux.cfg/default파일에 특정 구성이 필요합니다. 예를 들면 다음과 같습니다.# pxelinux default linux label linux kernel kernel.img initrd initrd.img append ip=dhcp inst.repo=example.com/redhat/BaseOS/s390x/os/

- 보안 실행

-

VM의 XML 구성에서 <

launchSecurity type="s390-pv"/>를 정의하여 준비된 보안 게스트 이미지로 VM을 부팅할 수 있습니다. 이렇게 하면 VM의 메모리를 암호화하여 하이퍼바이저가 원하지 않는 액세스로부터 보호합니다.

VM을 보안 실행 모드로 실행할 때는 다음 기능이 지원되지 않습니다.

-

vfio를 사용하여 장치 패스스루 -

virsh domstats및virsh memstat를 사용하여 메모리 정보 얻기 -

memballoon및virtio-rng가상 장치 - 대규모 페이지를 사용하여 메모리 백업

- 실시간 및 비라이브 VM 마이그레이션

- VM 저장 및 복원

-

메모리 스냅샷을 포함한 VM 스냅샷(

--memspec옵션 사용) -

전체 메모리 덤프 대신

virsh dump명령에--memory-only옵션을 지정합니다. - 248개 이상의 vCPU 보안 게스트의 vCPU 제한은 247입니다.

- 중첩된 가상화

추가 리소스

4.4. 다음 단계

IBM Z 시스템에 VM을 설정할 때는 게스트 OS가 "Spectre" 취약점으로부터 보호하는 것이 좋습니다. 이렇게 하려면

virsh edit명령을 사용하여 VM의 XML 구성을 수정하고 다음 방법 중 하나로 CPU를 구성합니다.호스트 CPU 모델을 사용합니다.

<cpu mode='host-model' check='partial'> <model fallback='allow'/> </cpu>

이렇게 하면 호스트에서 지원하는 경우

ppa15및bpb기능을 게스트에서 사용할 수 있습니다.특정 호스트 모델을 사용하는 경우

ppa15및pbp기능을 추가합니다. 다음 예제에서는 zEC12 CPU 모델을 사용합니다.<cpu mode='custom' match='exact' check='partial'> <model fallback='allow'>zEC12</model> <feature policy='force' name='ppa15'/> <feature policy='force' name='bpb'/> </cpu>z12 CPU를 사용하는 호스트 시스템에서

z114및z196CPU 모델과 함께ppa15기능을 사용할 때는 최신 마이크로 코드 수준(bundle 95 이상)도 사용해야 합니다.

4.5. 추가 리소스

5장. 웹 콘솔에서 가상 머신 관리

RHEL 8 호스트의 그래픽 인터페이스에서 가상 머신을 관리하려면 RHEL 8 웹 콘솔에서 Virtual Machines 창을 사용할 수 있습니다.

5.1. 웹 콘솔을 사용하여 가상 머신 관리 개요

RHEL 8 웹 콘솔은 시스템 관리를 위한 웹 기반 인터페이스입니다. 웹 콘솔은 해당 기능 중 하나로 호스트 시스템에서 VM(가상 시스템)의 그래픽 보기를 제공하고 이러한 VM을 생성, 액세스 및 구성할 수 있도록 합니다.

웹 콘솔을 사용하여 RHEL 8에서 VM을 관리하려면 먼저 가상화 를 위한 웹 콘솔 플러그인을 설치해야 합니다.

다음 단계

- 웹 콘솔에서 VM 관리를 활성화하는 방법에 대한 지침은 가상 시스템을 관리하기 위한 웹 콘솔 설정을 참조하십시오.

- 웹 콘솔에서 제공하는 VM 관리 작업의 전체 목록은 웹 콘솔에서 사용할 수 있는 가상 시스템 관리 기능을 참조하십시오.

- 현재 웹 콘솔에서는 사용할 수 없지만 virt-manager 애플리케이션에서 사용할 수 있는 기능 목록은 Virtual Machine Manager의 가상화 기능과 웹 콘솔 간의 차이점을 참조하십시오.

5.2. 가상 머신 관리를 위해 웹 콘솔 설정

RHEL 8 웹 콘솔을 사용하여 VM(가상 머신)을 관리하기 전에 호스트에 웹 콘솔 가상 머신 플러그인을 설치해야 합니다.

사전 요구 사항

웹 콘솔이 시스템에 설치 및 활성화되어 있는지 확인합니다.

# systemctl status cockpit.socket cockpit.socket - Cockpit Web Service Socket Loaded: loaded (/usr/lib/systemd/system/cockpit.socket [...]이 명령이

Unit cockpit.socket을 찾을 수 없는경우 웹 콘솔 설치 문서에 따라 웹 콘솔을 활성화합니다.

절차

cockpit-machines플러그인을 설치합니다.# yum install cockpit-machines

검증

-

예를 들어 브라우저에

https://localhost:9090주소를 입력하여 웹 콘솔에 액세스합니다. - 로그인합니다.

설치에 성공하면 Virtual Machines(가상 시스템) 가 웹 콘솔 사이드 메뉴에 나타납니다.

추가 리소스

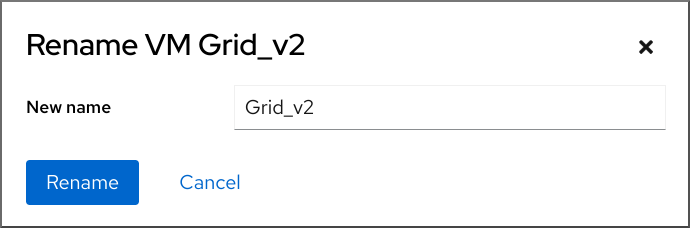

5.3. 웹 콘솔을 사용하여 가상 머신 이름 변경

이름 충돌을 방지하거나 사용 사례에 따라 새 고유한 이름을 할당하려면 기존 VM(가상 머신)의 이름을 변경해야 할 수 있습니다. VM의 이름을 변경하려면 RHEL 웹 콘솔을 사용할 수 있습니다.

사전 요구 사항

- 웹 콘솔 VM 플러그인이 시스템에 설치되어 있습니다.

- VM이 종료되었습니다.

절차

Virtual Machines (가상 머신 ) 인터페이스에서 이름을 변경할 VM의 메뉴 버튼을 클릭합니다.

다양한 VM 작업에 대한 제어가 포함된 드롭다운 메뉴가 표시됩니다.

Rename 을 클릭합니다.

Rename a VM (VM 이름 변경) 대화 상자가 나타납니다.

- New name (새 이름) 필드에 VM의 이름을 입력합니다.

- Rename 을 클릭합니다.

검증

- 가상 머신 인터페이스에 새 VM 이름이 표시되는지 확인합니다.

5.4. 웹 콘솔에서 사용할 수 있는 가상 머신 관리 기능

RHEL 8 웹 콘솔을 사용하면 다음 작업을 수행하여 시스템의 VM(가상 머신)을 관리할 수 있습니다.

표 5.1. RHEL 8 웹 콘솔에서 수행할 수 있는 VM 관리 작업

| Task | 자세한 내용은 를 참조하십시오. |

|---|---|

| VM을 생성하고 게스트 운영 체제로 설치합니다. | |

| VM 삭제 | |

| VM을 시작, 종료, 다시 시작 | |

| 다양한 콘솔을 사용하여 VM과 연결 및 상호 작용 | |

| VM에 대한 다양한 정보보기 | |

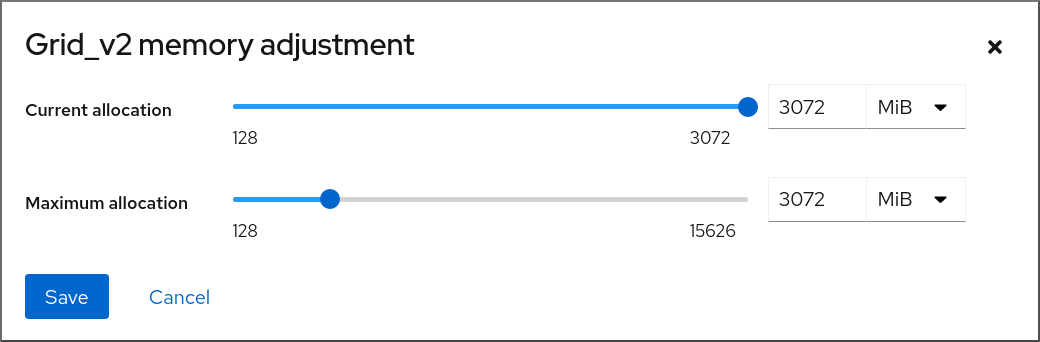

| VM에 할당된 호스트 메모리 조정 | |

| VM의 네트워크 연결을 관리합니다 | |

| 호스트에서 사용 가능한 VM 스토리지를 관리하고 가상 디스크를 VM에 연결합니다. | |

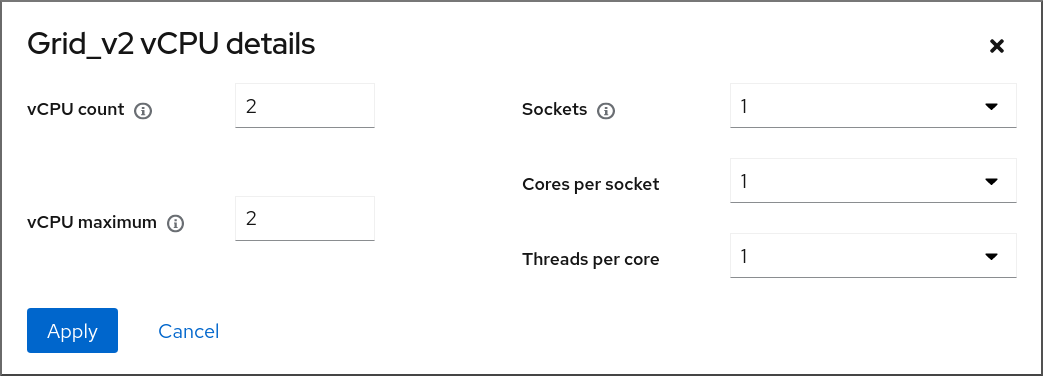

| VM의 가상 CPU 설정 구성 | |

| VM 실시간 마이그레이션 | |

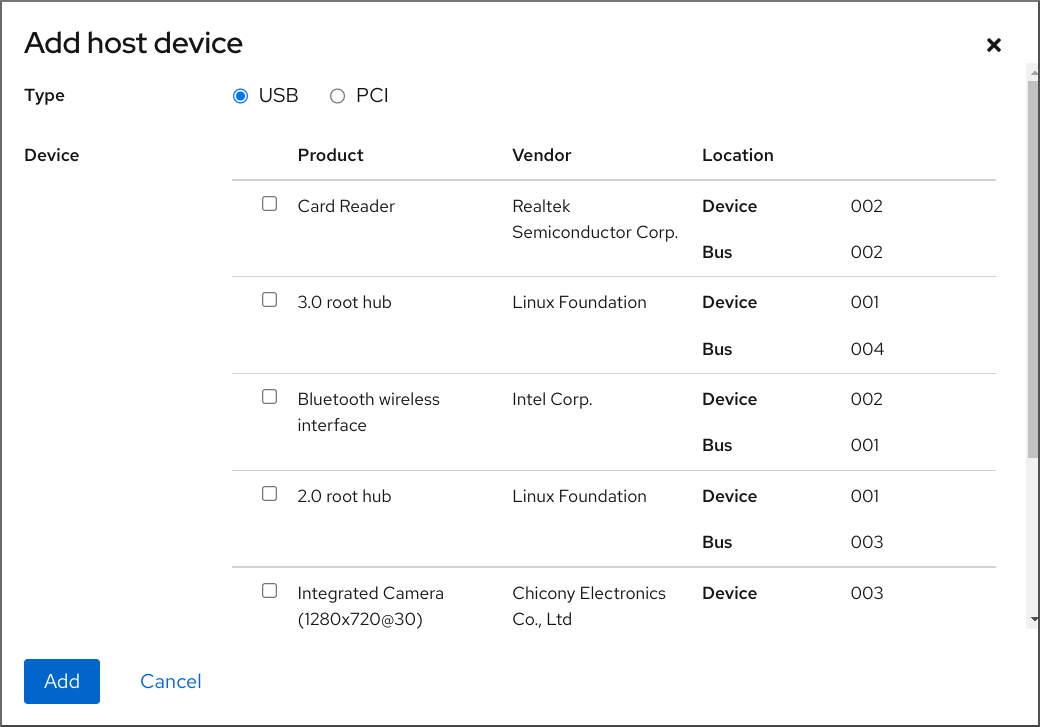

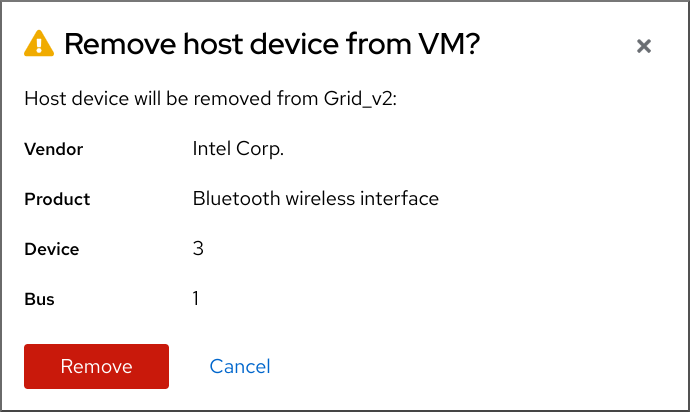

| 호스트 장치 관리 | |

| 가상 광 드라이브 관리 | |

| 워치독 장치 연결 |

5.5. Virtual Machine Manager와 웹 콘솔의 가상화 기능 간 차이점

virt-manager(가상 머신 관리자) 애플리케이션은 RHEL 8에서 지원되지만 더 이상 사용되지 않습니다. 웹 콘솔은 후속 주요 릴리스에서 교체될 예정입니다. 따라서 GUI에서 가상화를 관리하는 데 웹 콘솔에 익숙해지는 것이 좋습니다.

그러나 RHEL 8에서는 일부 VM 관리 작업은 virt-manager 또는 명령줄에서만 수행할 수 있습니다. 다음 표에서는 virt-manager 에서 사용할 수 있지만 RHEL 8.0 웹 콘솔에서 사용할 수 없는 기능을 강조 표시합니다.

이후 마이너 버전의 RHEL 8에서 기능을 사용할 수 있는 경우 웹 콘솔 도입 열에 최소 RHEL 8 버전이 표시됩니다.

표 5.2. RHEL 8.0에서 웹 콘솔을 사용하여 수행할 수 없는 VM managemennt 작업

| Task | 웹 콘솔 지원 도입 | CLI를 사용하여 대체 방법 |

|---|---|---|

| 호스트가 부팅될 때 시작하도록 가상 머신 설정 | RHEL 8.1 |

|

| 가상 머신 일시 중단 | RHEL 8.1 |

|

| 일시 중단된 가상 머신 재시작 | RHEL 8.1 |

|

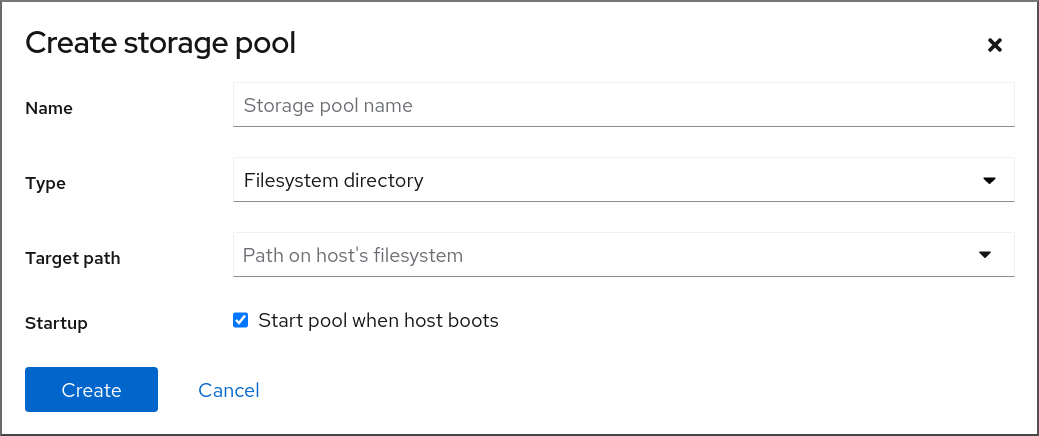

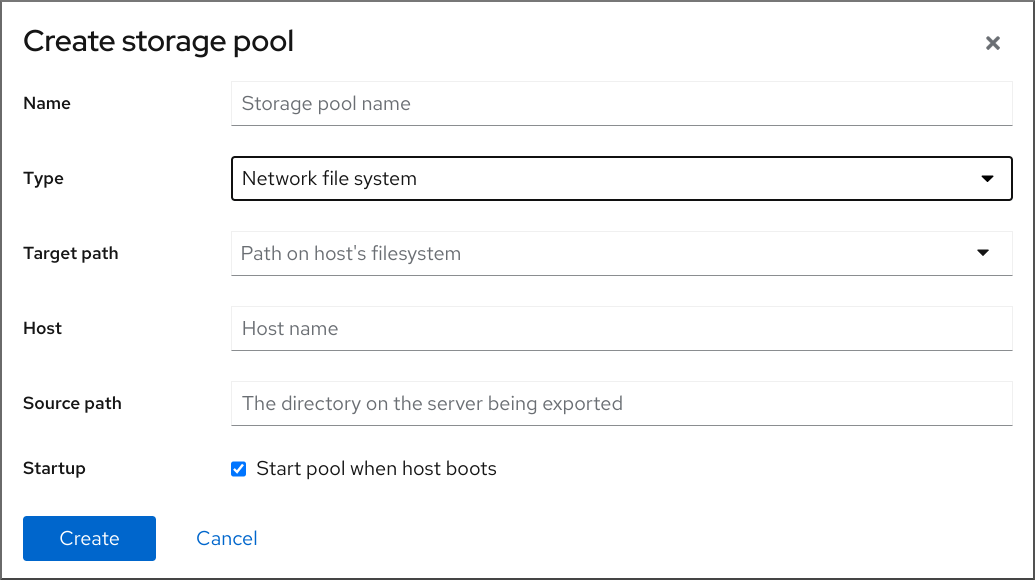

| 파일 시스템 디렉터리 스토리지 풀 생성 | RHEL 8.1 |

|

| NFS 스토리지 풀 생성 | RHEL 8.1 |

|

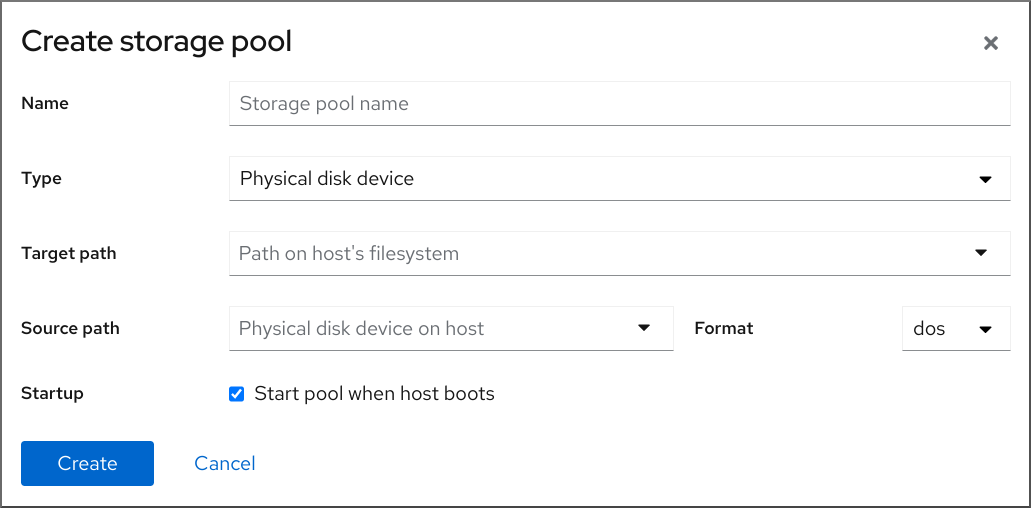

| 물리적 디스크 장치 스토리지 풀 생성 | RHEL 8.1 |

|

| LVM 볼륨 그룹 스토리지 풀 생성 | RHEL 8.1 |

|

| 파티션 기반 스토리지 풀 생성 | 현재 사용할 수 없습니다 |

|

| GlusterFS 기반 스토리지 풀 생성 | 현재 사용할 수 없습니다 |

|

| SCSI 장치를 사용하여 vHBA 기반 스토리지 풀 생성 | 현재 사용할 수 없습니다 |

|

| 다중 경로 기반 스토리지 풀 생성 | 현재 사용할 수 없습니다 |

|

| RBD 기반 스토리지 풀 생성 | 현재 사용할 수 없습니다 |

|

| 새 스토리지 볼륨 생성 | RHEL 8.1 |

|

| 새 가상 네트워크 추가 | RHEL 8.1 |

|

| 가상 네트워크 삭제 | RHEL 8.1 |

|

| 호스트 머신 인터페이스에서 가상 머신으로 브리지 만들기 | 현재 사용할 수 없습니다 |

|

| 스냅샷 생성 | 현재 사용할 수 없습니다 |

|

| 스냅샷으로 되돌리기 | 현재 사용할 수 없습니다 |

|

| 스냅샷 삭제 | 현재 사용할 수 없습니다 |

|

| 가상 머신 복제 | RHEL 8.4 |

|

| 다른 호스트 머신으로 가상 머신 마이그레이션 | RHEL 8.5 |

|

| VM에 호스트 장치 연결 | RHEL 8.5 |

|

| VM에서 호스트 장치 제거 | RHEL 8.5 |

|

6장. 가상 머신에 대한 정보 보기

RHEL 8에서 가상화 배포의 모든 측면을 조정하거나 해결해야 할 경우 일반적으로 수행해야 하는 첫 번째 단계는 가상 시스템의 현재 상태 및 구성에 대한 정보를 확인하는 것입니다. 이를 위해 명령줄 인터페이스 또는 웹 콘솔을 사용할 수 있습니다. VM의 XML 구성에서 정보를 볼 수도 있습니다.

6.1. 명령줄 인터페이스를 사용하여 가상 머신 정보 보기

호스트 및 해당 구성의 VM(가상 시스템)에 대한 정보를 검색하려면 다음 명령 중 하나 이상을 사용합니다.

절차

호스트에서 VM 목록을 가져오려면 다음을 수행합니다.

# virsh list --all Id Name State ---------------------------------- 1 testguest1 running - testguest2 shut off - testguest3 shut off - testguest4 shut off특정 VM에 대한 기본 정보를 얻으려면 다음을 수행합니다.

# virsh dominfo testguest1 Id: 1 Name: testguest1 UUID: a973666f-2f6e-415a-8949-75a7a98569e1 OS Type: hvm State: running CPU(s): 2 CPU time: 188.3s Max memory: 4194304 KiB Used memory: 4194304 KiB Persistent: yes Autostart: disable Managed save: no Security model: selinux Security DOI: 0 Security label: system_u:system_r:svirt_t:s0:c486,c538 (enforcing)특정 VM의 전체 XML 구성을 얻으려면 다음을 수행합니다.

# virsh dumpxml testguest2 <domain type='kvm' id='1'> <name>testguest2</name> <uuid>a973434f-2f6e-4ěša-8949-76a7a98569e1</uuid> <metadata> [...]VM의 디스크 및 기타 블록 장치에 대한 자세한 내용은 다음을 수행합니다.

# virsh domblklist testguest3 Target Source --------------------------------------------------------------- vda /var/lib/libvirt/images/testguest3.qcow2 sda - sdb /home/username/Downloads/virt-p2v-1.36.10-1.el7.isoVM 스토리지 관리에 대한 지침은 가상 시스템의 스토리지 관리를 참조하십시오.

VM의 파일 시스템과 마운트 지점에 대한 정보를 얻으려면 다음을 수행합니다.

# virsh domfsinfo testguest3 Mountpoint Name Type Target ------------------------------------ / dm-0 xfs /boot vda1 xfs

특정 VM의 vCPU에 대한 자세한 내용을 얻으려면 다음을 수행합니다.

# virsh vcpuinfo testguest4 VCPU: 0 CPU: 3 State: running CPU time: 103.1s CPU Affinity: yyyy VCPU: 1 CPU: 0 State: running CPU time: 88.6s CPU Affinity: yyyyVM에서 vCPU를 구성하고 최적화하려면 가상 머신 CPU 성능 최적화를 참조하십시오.

호스트의 모든 가상 네트워크 인터페이스를 나열하려면 다음을 수행합니다.

# virsh net-list --all Name State Autostart Persistent --------------------------------------------- default active yes yes labnet active yes yes특정 인터페이스에 대한 정보를 보려면 다음을 수행합니다.

# virsh net-info default Name: default UUID: c699f9f6-9202-4ca8-91d0-6b8cb9024116 Active: yes Persistent: yes Autostart: yes Bridge: virbr0네트워크 인터페이스, VM 네트워크 및 구성 방법에 대한 자세한 내용은 가상 머신 네트워크 연결 구성을 참조하십시오.

- 호스트에서 스토리지 풀 및 스토리지 볼륨에 대한 정보를 보는 방법에 대한 자세한 내용은 CLI를 사용하여 가상 머신 스토리지 정보 보기를 참조하십시오.

6.2. 웹 콘솔을 사용하여 가상 머신 정보 보기

RHEL 8 웹 콘솔을 사용하면 웹 콘솔 세션이 액세스할 수 있는 모든 VM 및 스토리지 풀에 대한 정보를 볼 수 있습니다.

웹 콘솔 세션이 연결된 선택된 VM에 대한 정보를 볼 수 있습니다. 여기에는 디스크,가상 네트워크 인터페이스 및 리소스 사용량에 대한 정보가 포함됩니다.

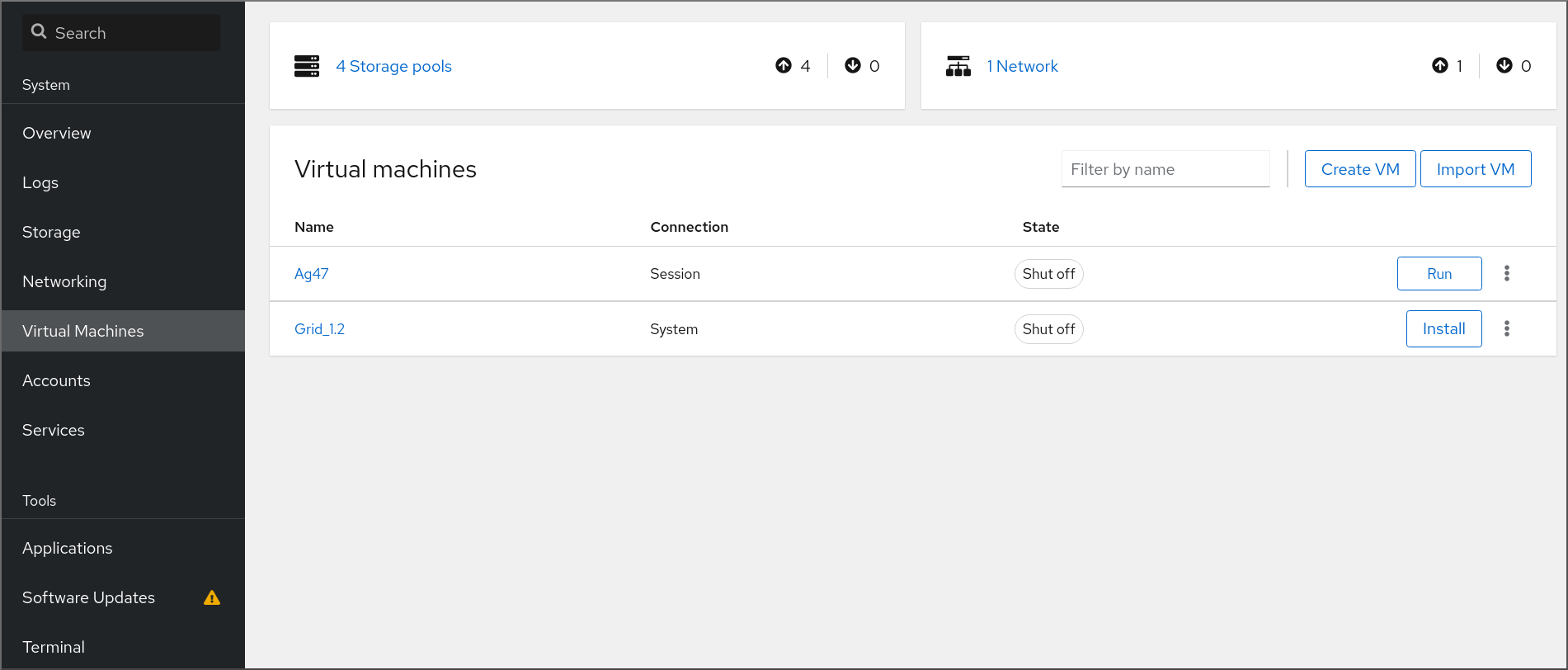

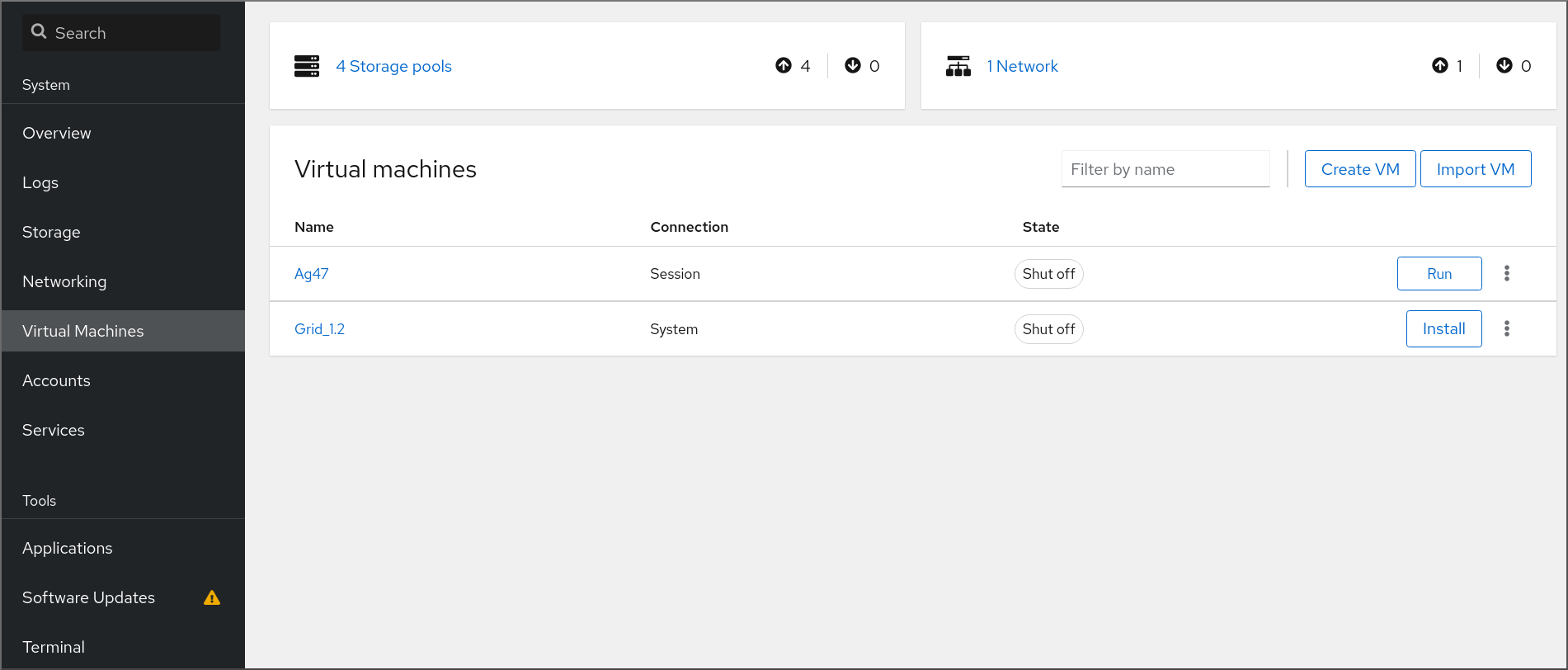

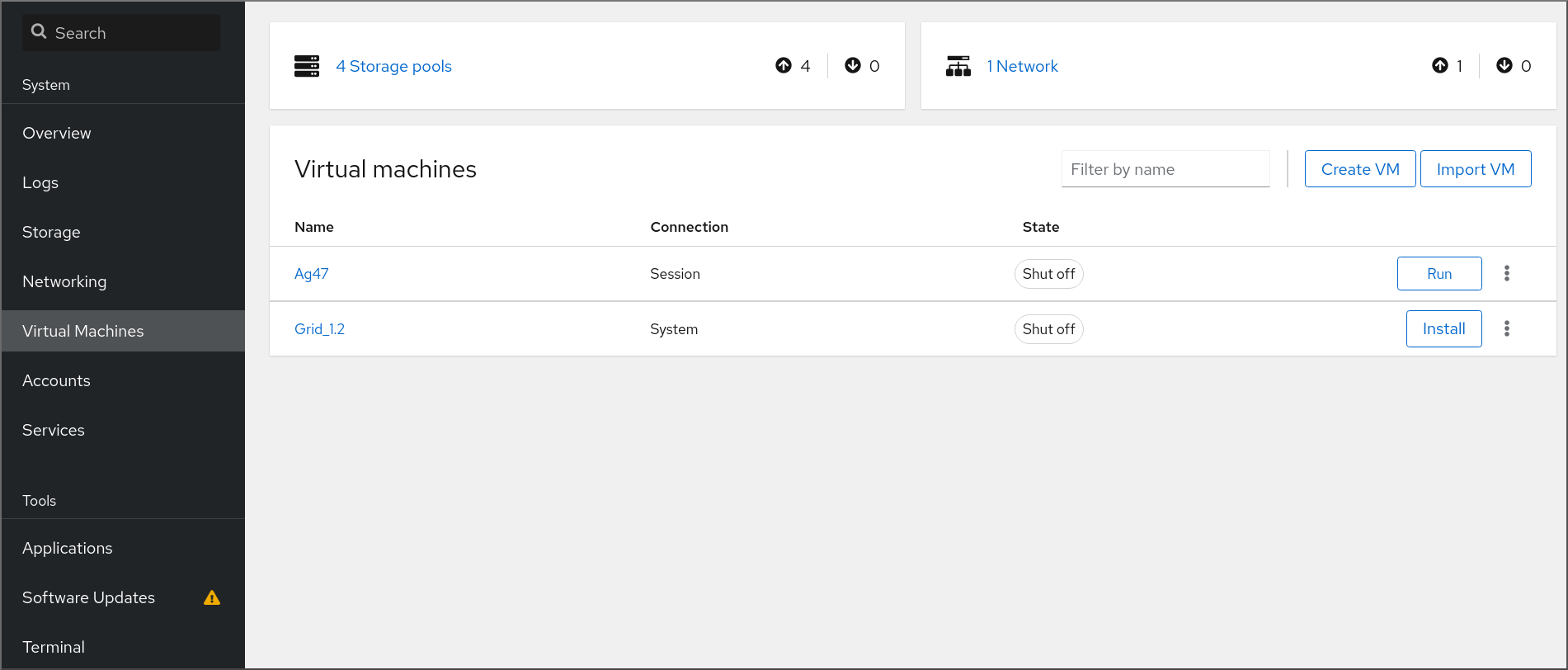

6.2.1. 웹 콘솔에서 가상화 개요 보기

웹 콘솔을 사용하면 사용 가능한 VM(가상 머신), 스토리지 풀 및 네트워크에 대한 요약된 정보가 포함된 가상화 개요에 액세스할 수 있습니다.

사전 요구 사항

- 웹 콘솔 VM 플러그인이 시스템에 설치되어 있습니다.

절차

웹 콘솔의 사이드 메뉴에서 Virtual Machines (가상 시스템)를 클릭합니다.

사용 가능한 스토리지 풀, 사용 가능한 네트워크 및 웹 콘솔이 연결된 VM에 대한 정보가 포함된 대화 상자가 나타납니다.

이 정보에는 다음이 포함됩니다.

- 스토리지 풀 - 웹 콘솔 및 해당 상태에서 액세스할 수 있는 활성 또는 비활성 스토리지 풀 수입니다.

- Networks(네트워크) - 웹 콘솔 및 해당 상태에서 액세스할 수 있는 활성 또는 비활성 네트워크 수입니다.

- Name (이름) - VM의 이름입니다.

- connection - libvirt 연결, 시스템 또는 세션 유형입니다.

- State - VM 상태입니다.

추가 리소스

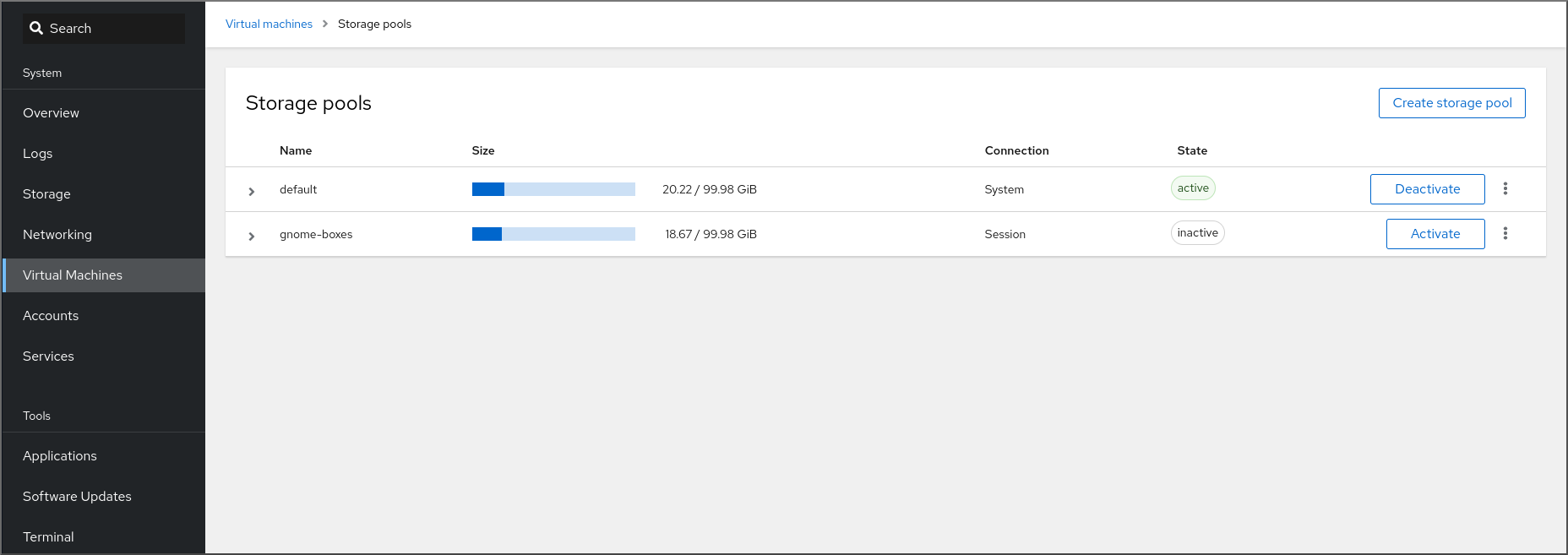

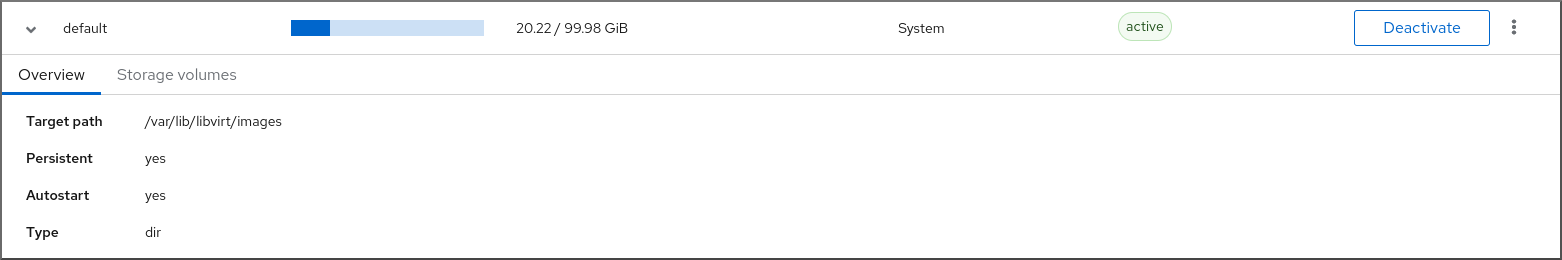

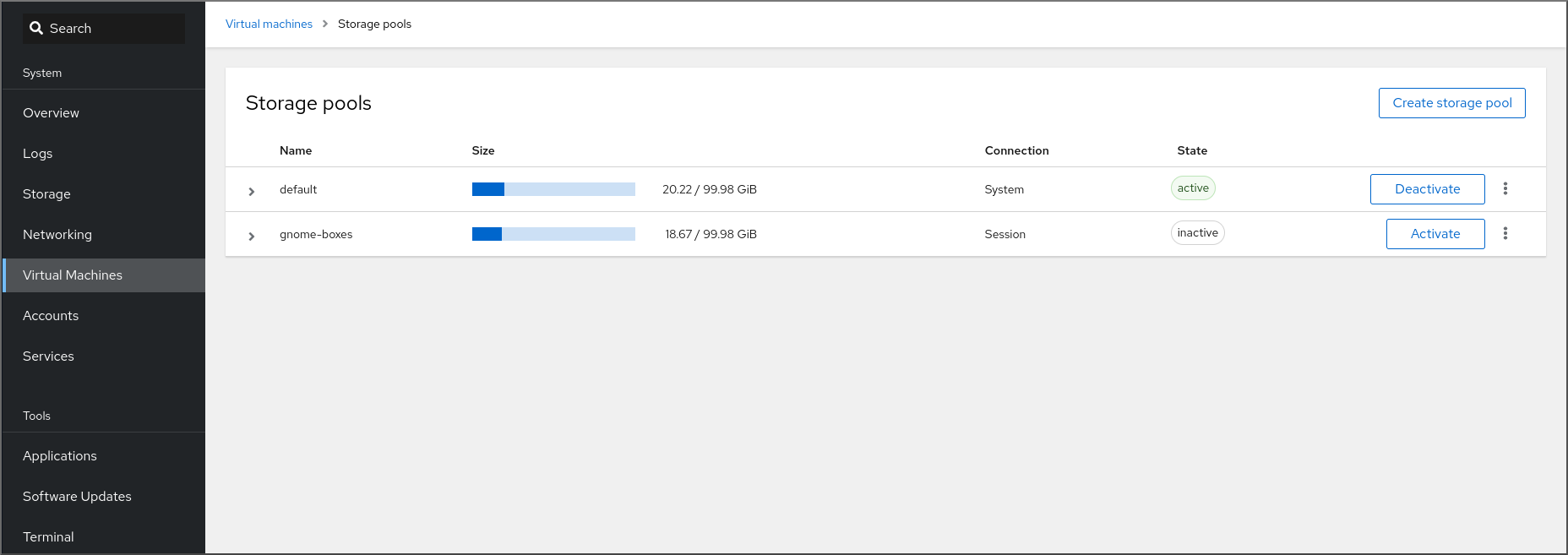

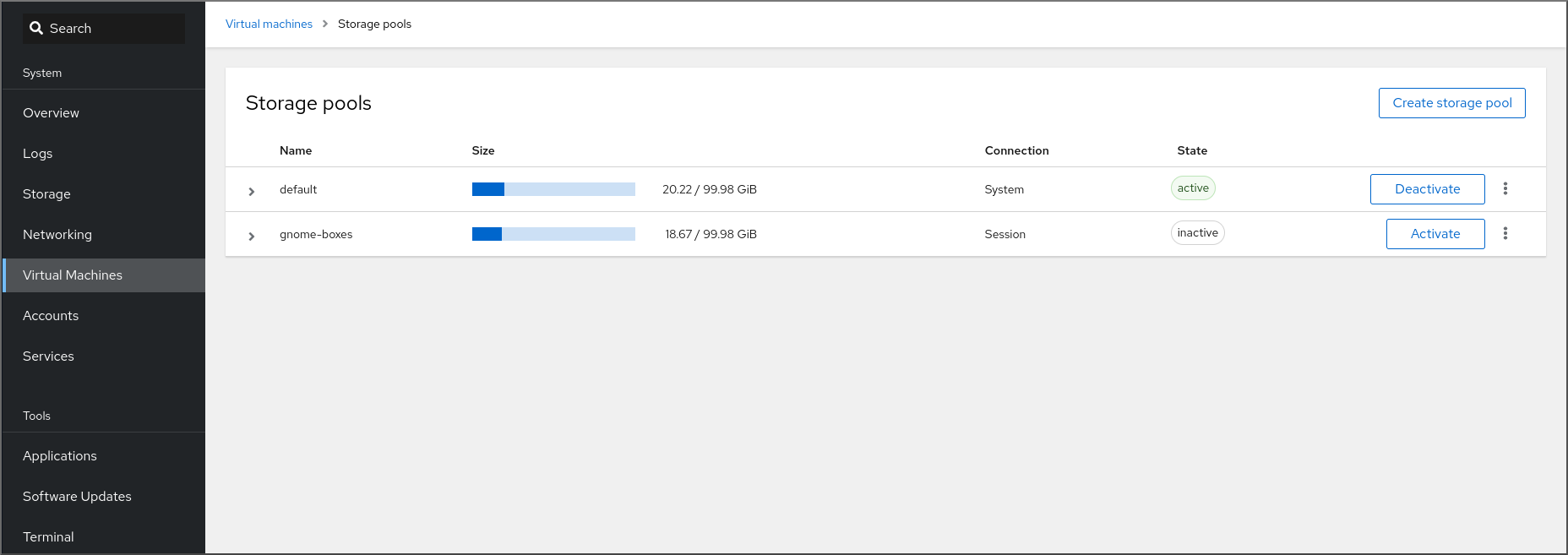

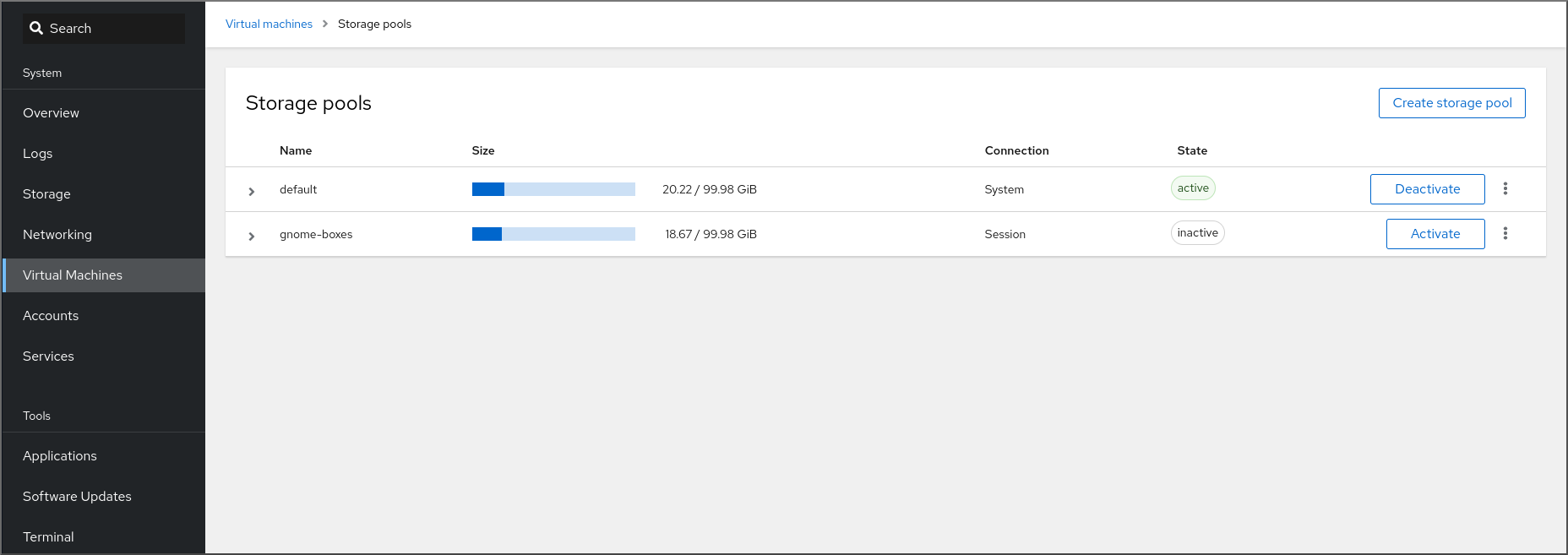

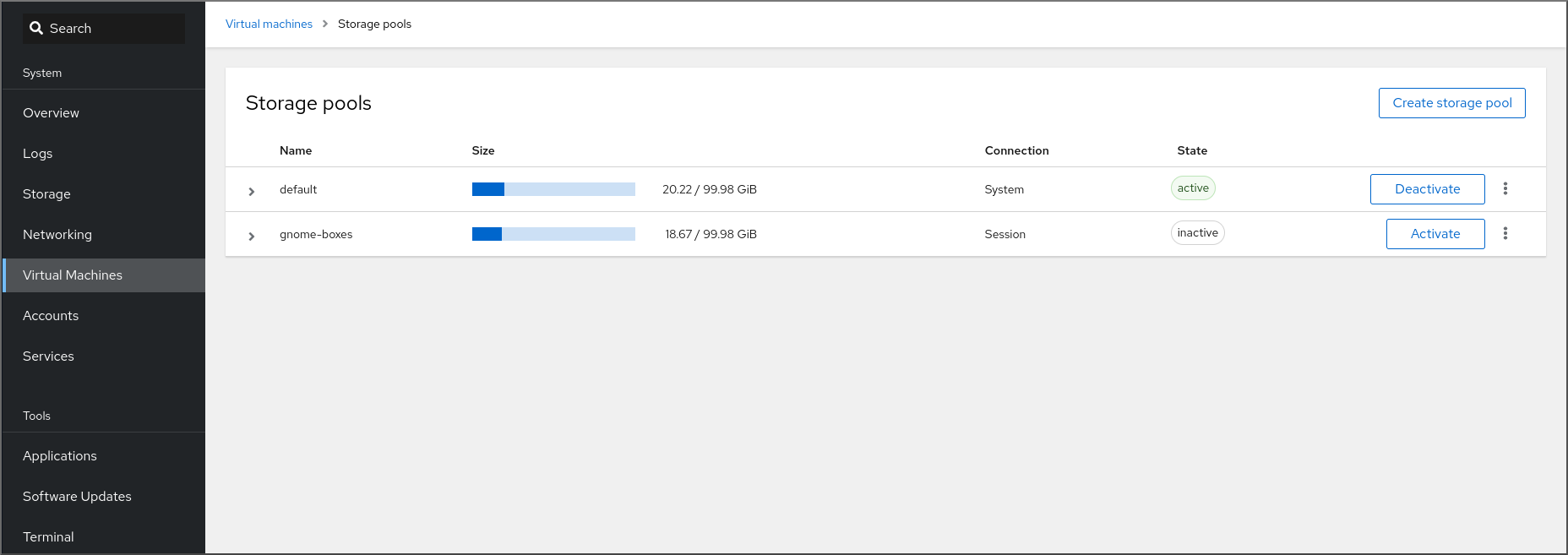

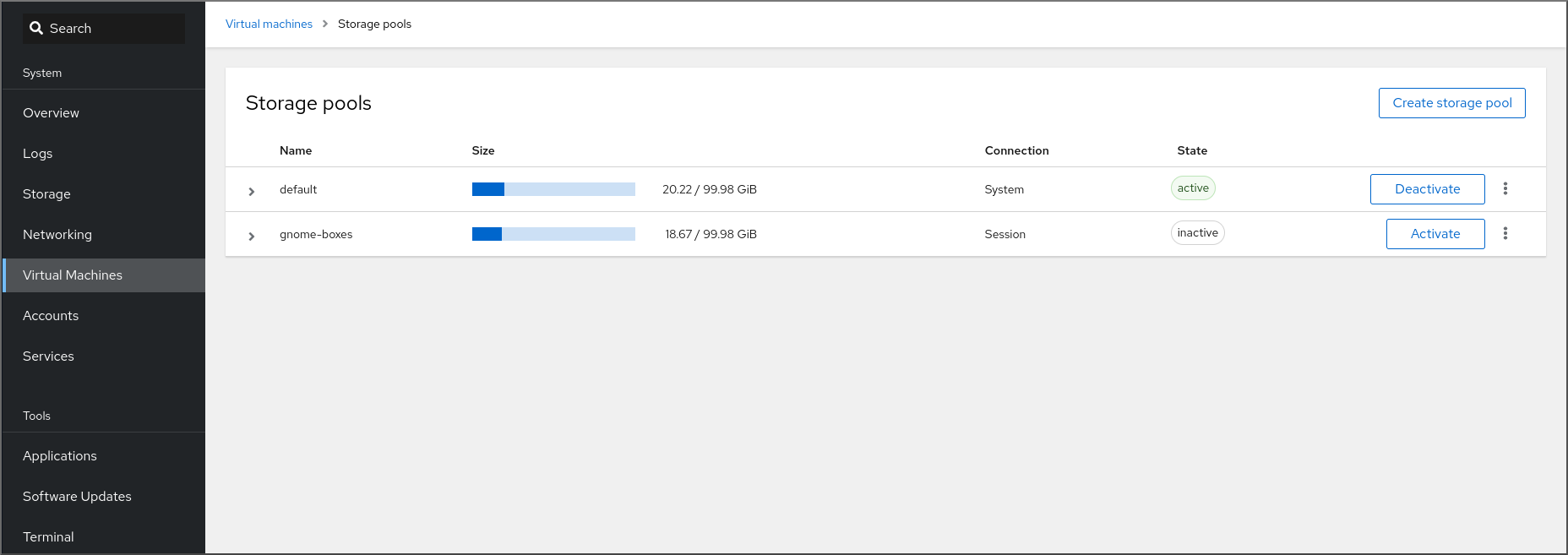

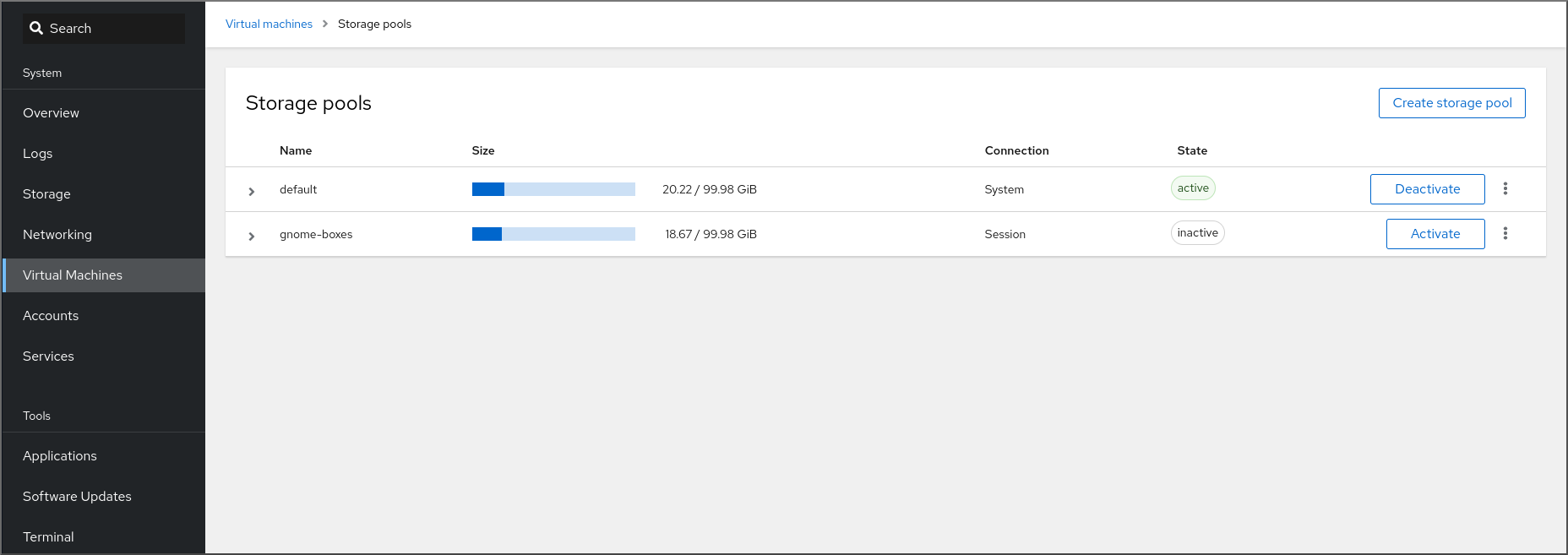

6.2.2. 웹 콘솔을 사용하여 스토리지 풀 정보 보기

웹 콘솔을 사용하면 시스템에서 사용 가능한 스토리지 풀에 대한 자세한 정보를 볼 수 있습니다. 스토리지 풀을 사용하여 가상 시스템의 디스크 이미지를 생성할 수 있습니다.

사전 요구 사항

- 웹 콘솔 VM 플러그인이 시스템에 설치되어 있습니다.

절차

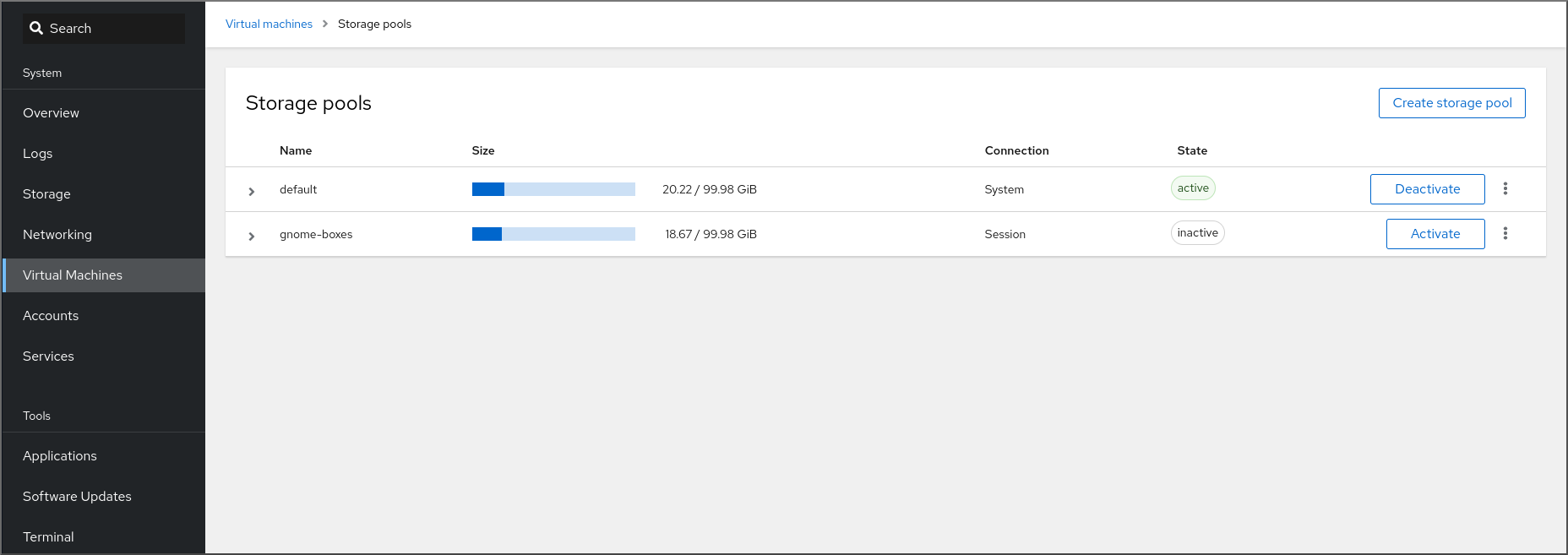

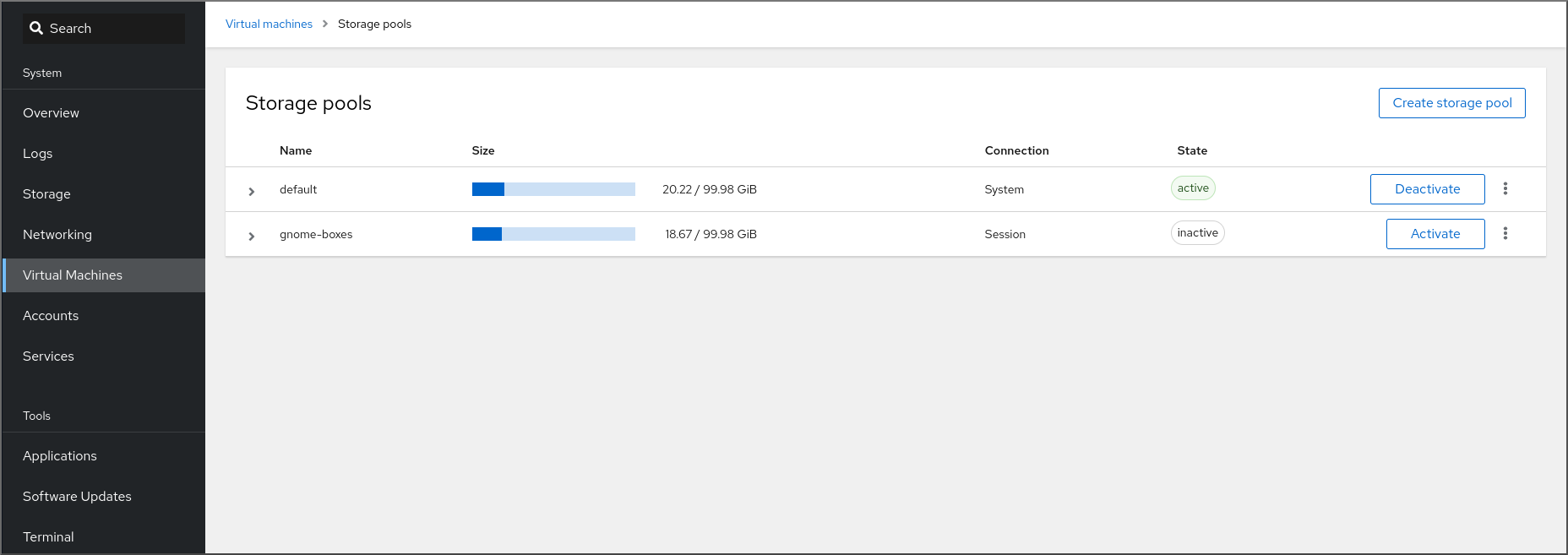

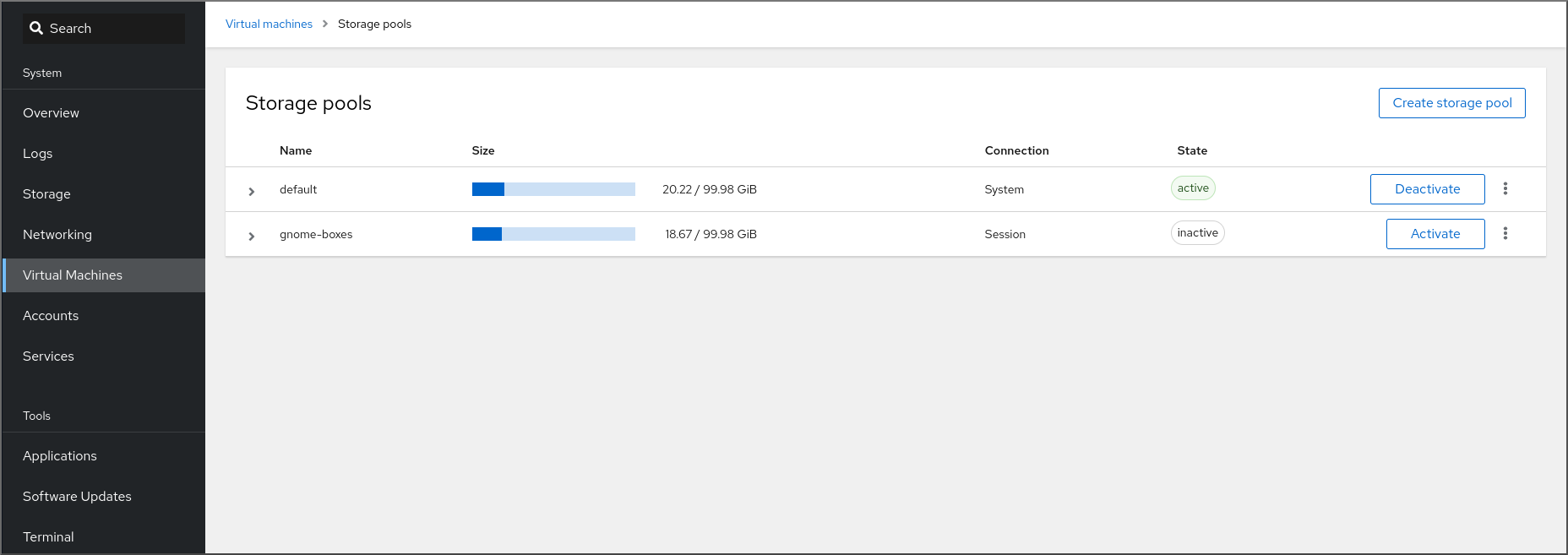

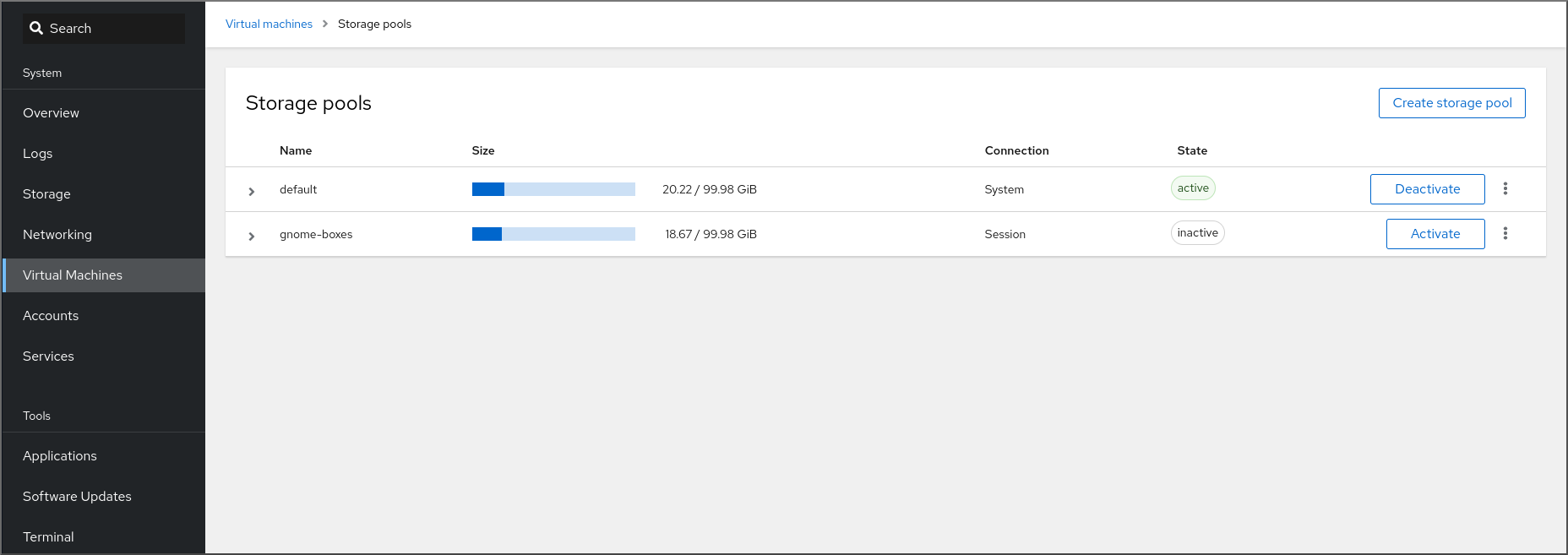

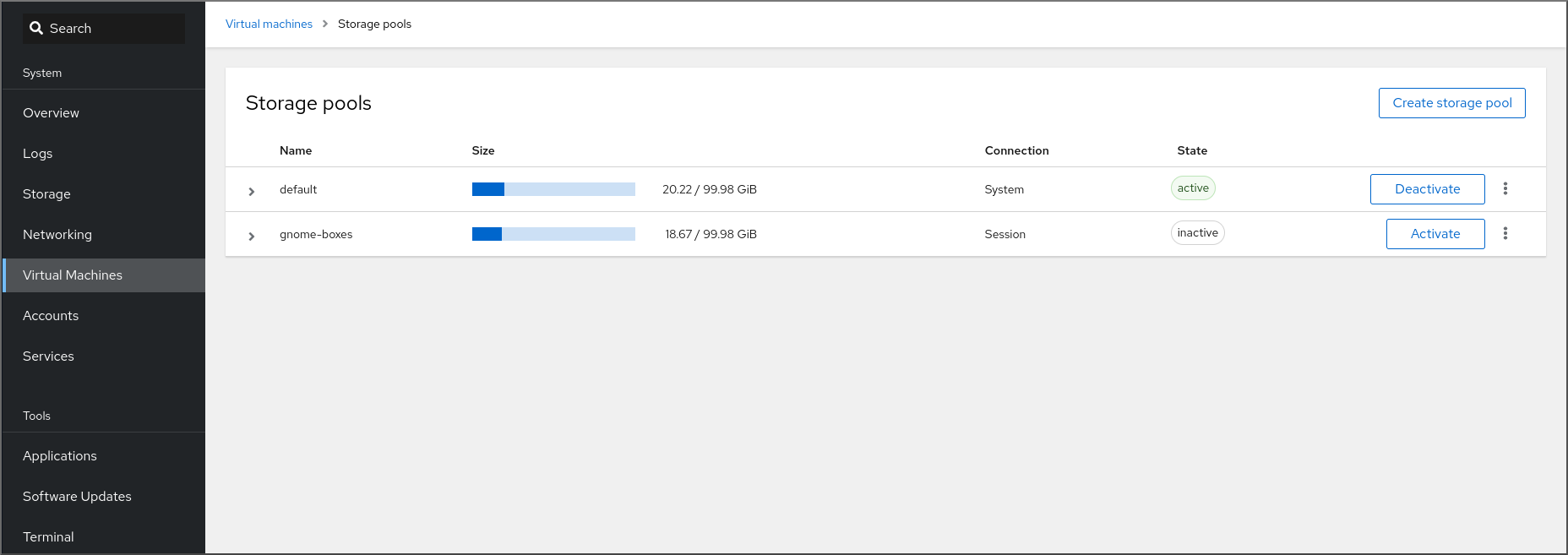

가상 머신 인터페이스 상단에 있는 Storage Pools (스토리지 풀)를 클릭합니다.

구성된 스토리지 풀 목록을 보여주는 스토리지 풀 창이 표시됩니다.

이 정보에는 다음이 포함됩니다.

- name - 스토리지 풀의 이름입니다.

- size - 스토리지 풀의 현재 할당 및 총 용량입니다.

- 연결 - 스토리지 풀 액세스에 사용되는 연결입니다.

- state - 스토리지 풀의 상태입니다.

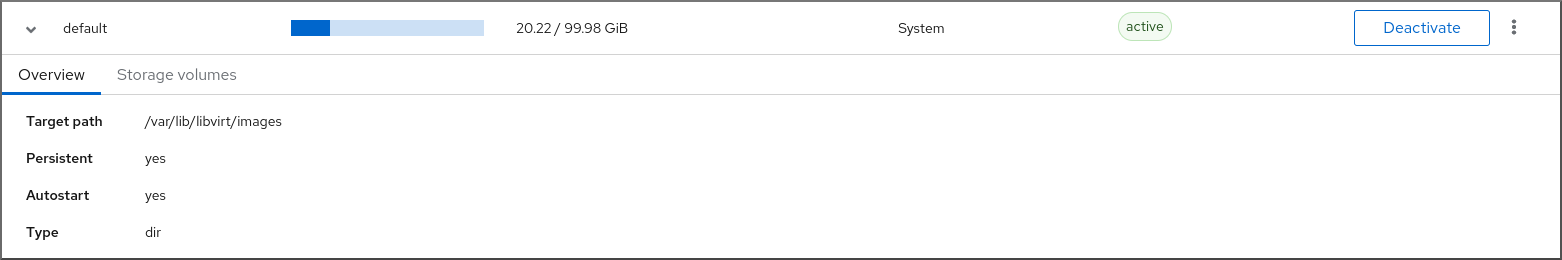

정보를 보려는 스토리지 풀 옆에 있는 화살표를 클릭합니다.

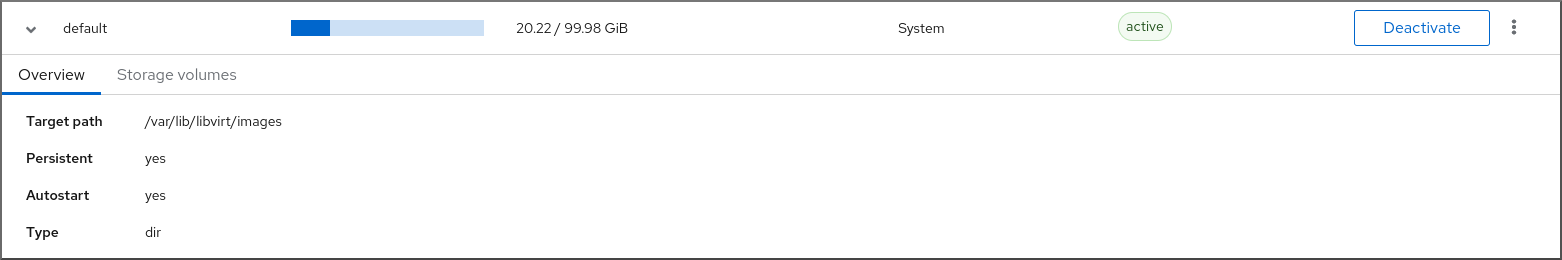

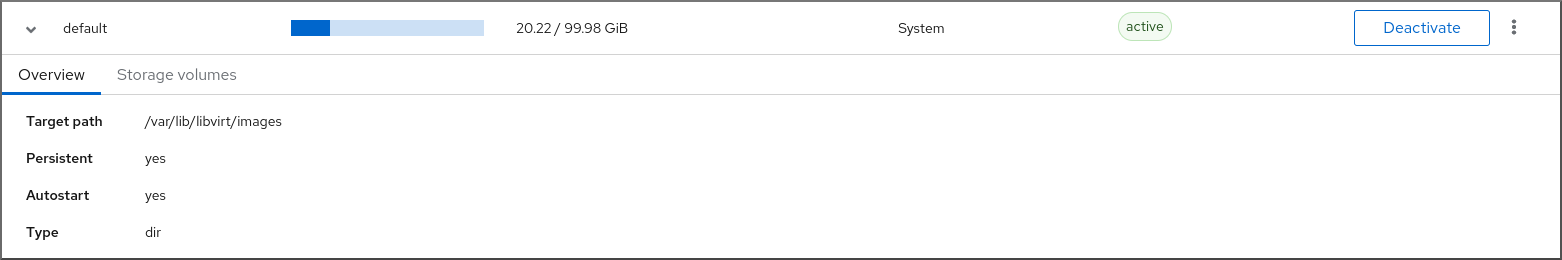

행이 확장되어 선택한 스토리지 풀에 대한 자세한 정보가 포함된 Overview(개요) 창을 표시합니다.

정보에는 다음이 포함됩니다.

-

타겟 경로 - 디렉터리가 지원하는 스토리지 풀 유형의 소스(예:

dir또는netfs)입니다. - persistent - 스토리지 풀에 영구 구성이 있는지 여부를 나타냅니다.

- autostart - 시스템 부팅 시 스토리지 풀이 자동으로 시작되는지 여부를 나타냅니다.

- Type - 스토리지 풀의 유형입니다.

-

타겟 경로 - 디렉터리가 지원하는 스토리지 풀 유형의 소스(예:

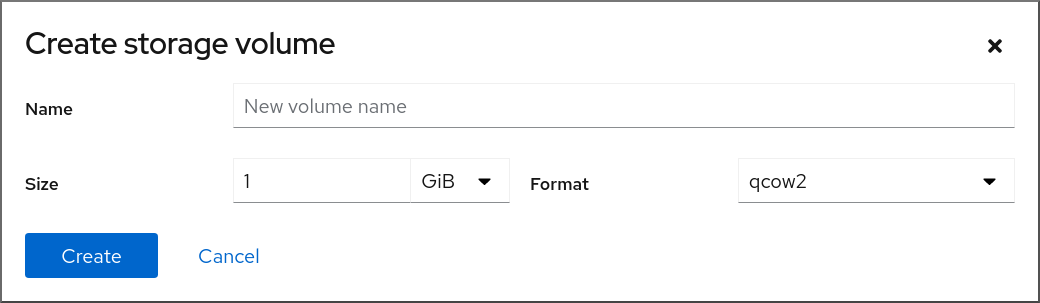

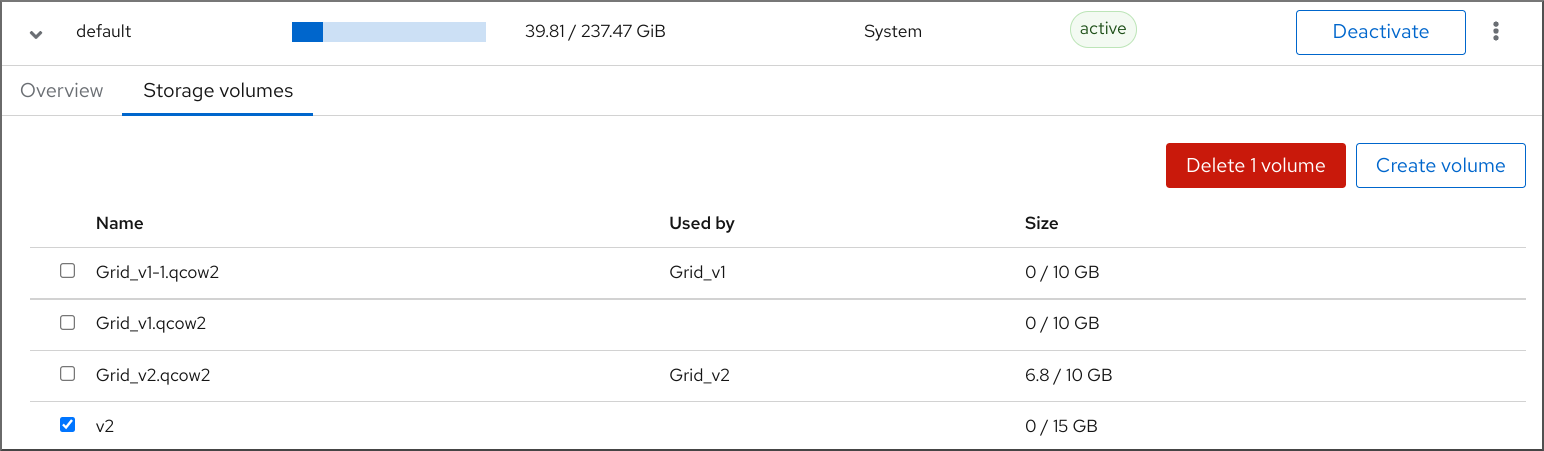

스토리지 풀과 연결된 스토리지 볼륨 목록을 보려면 Storage(스토리지) Volumes (볼륨) 를 클릭합니다.

Storage Volumes(스토리지 볼륨) 창이 표시되고 구성된 스토리지 볼륨 목록이 표시됩니다.

정보에는 다음이 포함됩니다.

- name - 스토리지 볼륨의 이름입니다.

- 현재 스토리지 볼륨을 사용하고 있는 VM 에서 사용합니다.

- size - 볼륨의 크기입니다.

추가 리소스

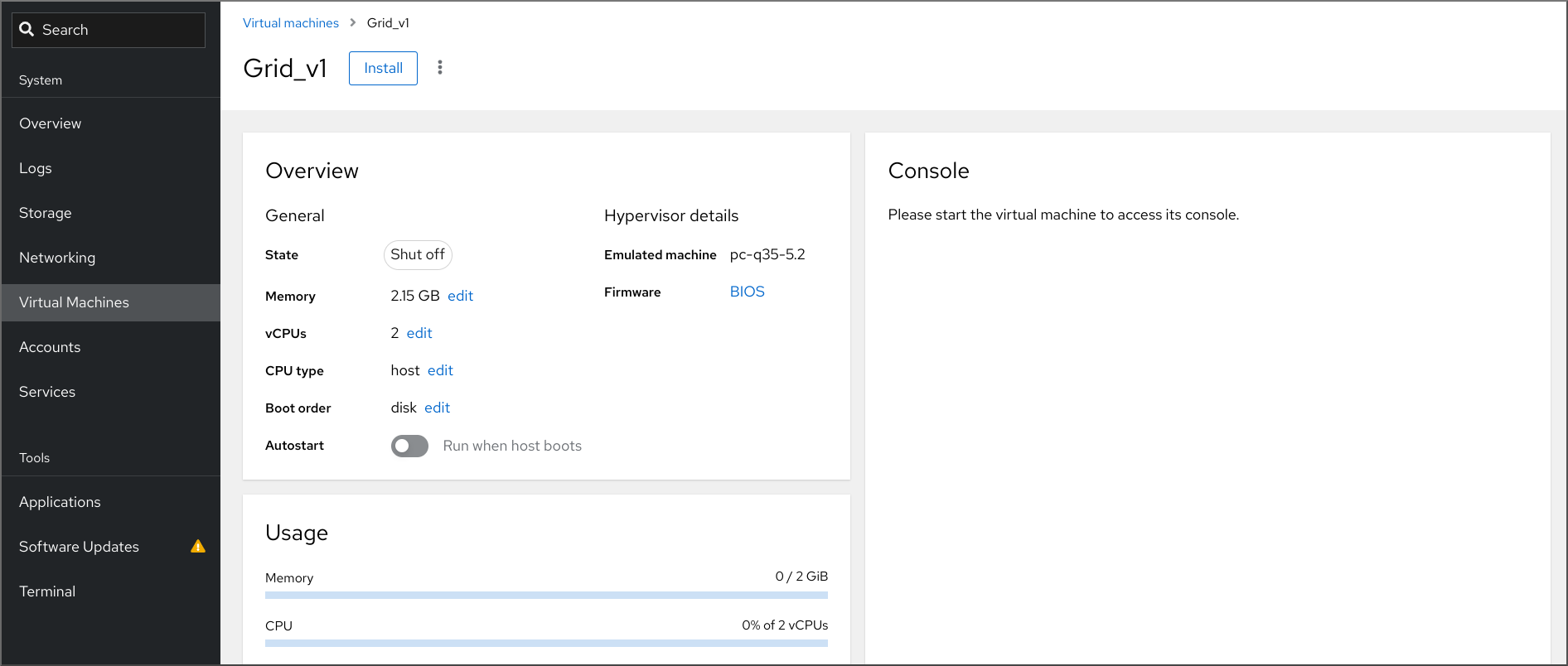

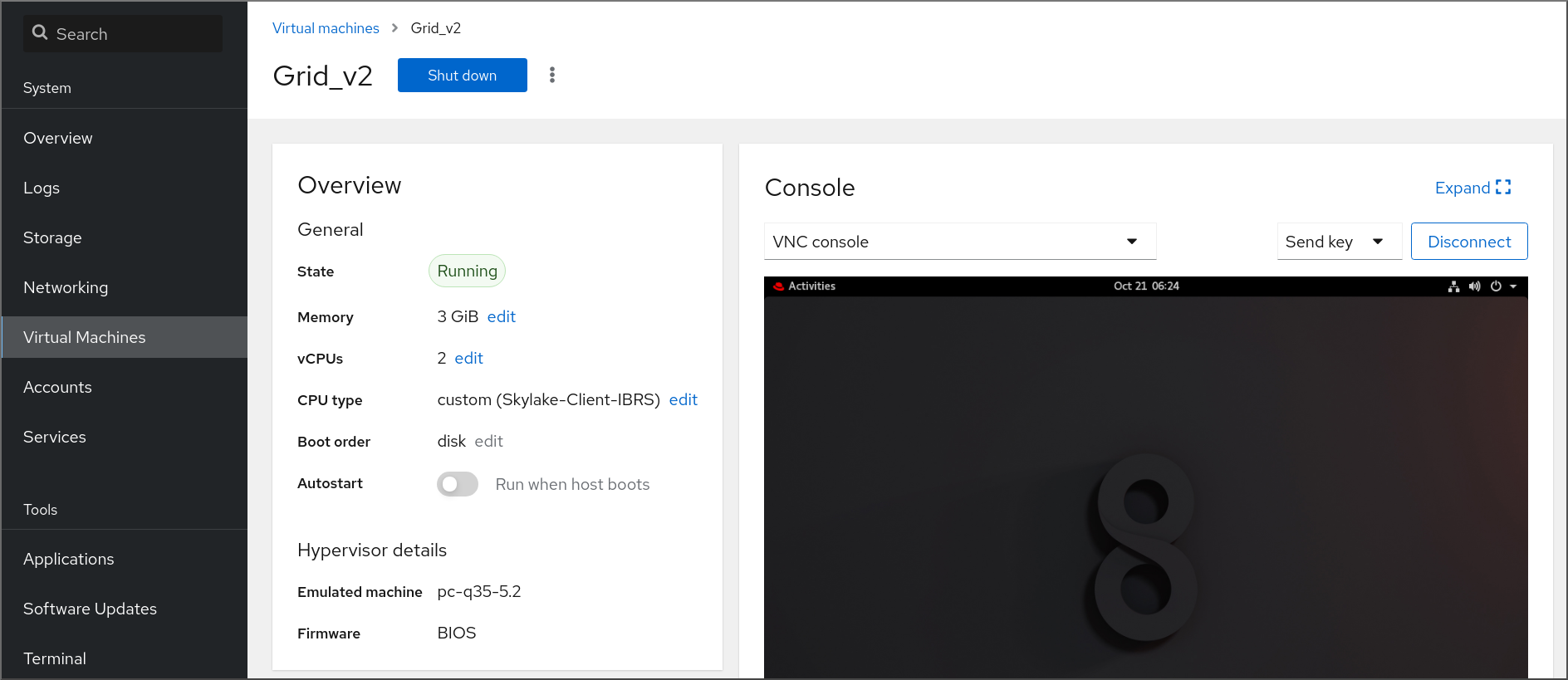

6.2.3. 웹 콘솔에서 기본 가상 머신 정보 보기

웹 콘솔을 사용하면 선택한 VM(가상 머신)에 대한 할당된 리소스 또는 하이퍼바이저 세부 정보와 같은 기본 정보를 볼 수 있습니다.

사전 요구 사항

- 웹 콘솔 VM 플러그인이 시스템에 설치되어 있습니다.

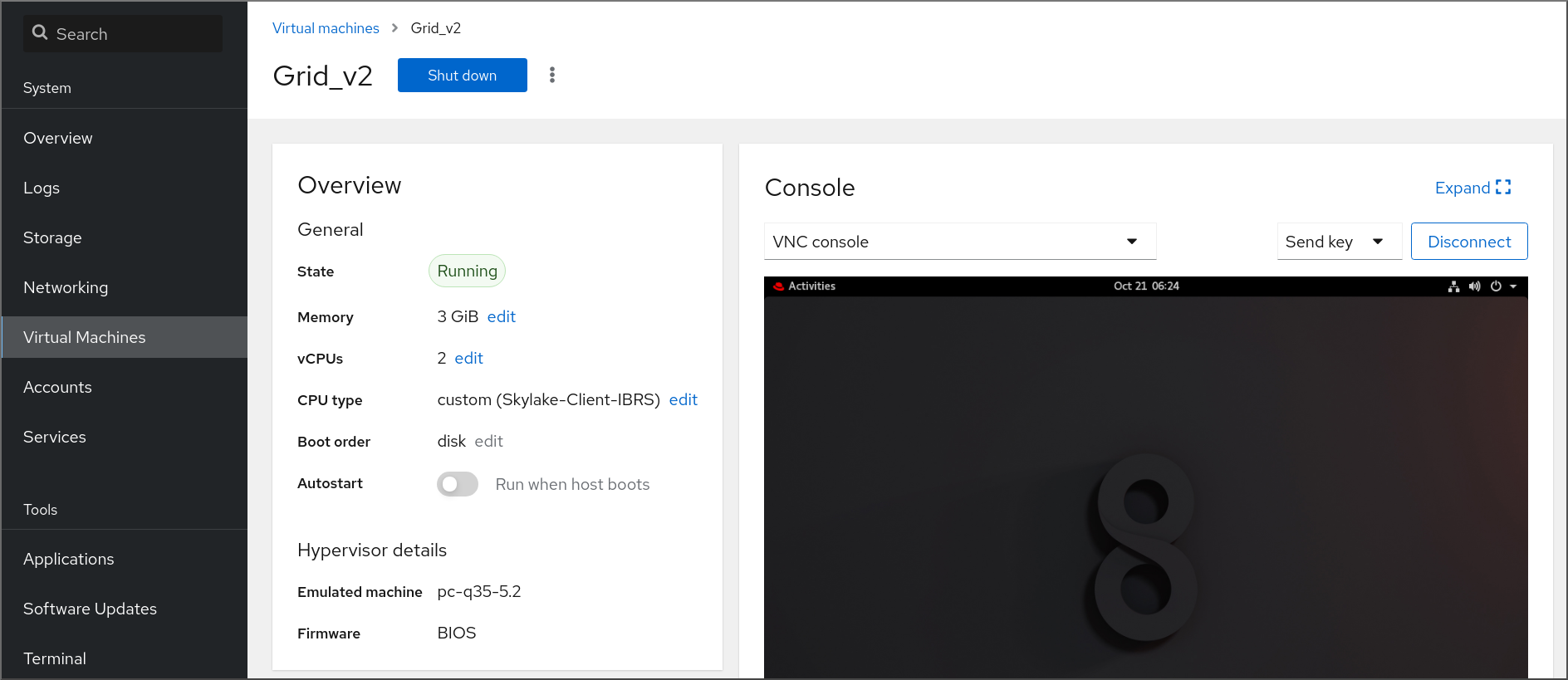

절차

- 웹 콘솔 사이드 메뉴에서 Virtual Machines (가상 시스템)를 클릭합니다.

보려는 정보를 보여주는 VM을 클릭합니다.

VM의 그래픽 인터페이스에 액세스하기 위한 선택한 VM 및 콘솔 섹션에 대한 기본 정보가 포함된 Overview(개요) 섹션이 포함된 새 페이지가 열립니다.

개요 섹션에는 다음과 같은 일반 VM 세부 정보가 포함되어 있습니다.

- Status (상태) - VM 상태, Running 또는 Shut off(실행 중 또는 종료)입니다.

- memory - VM에 할당된 메모리 양입니다.

- vCPU - VM에 대해 구성된 가상 CPU 수입니다.

- CPU 유형 - VM에 대해 구성된 가상 CPU의 아키텍처입니다.

- Boot Order(부팅 순서) - VM에 대해 구성된 부팅 순서입니다.

- auto start - VM에 대해 자동 시작 여부가 활성화됩니다.

이 정보에는 다음과 같은 하이퍼바이저 세부 정보도 포함됩니다.

- 에뮬레이트 된 시스템 - VM에서 에뮬레이트된 시스템 유형입니다.

- 펌웨어 - VM 펌웨어입니다.

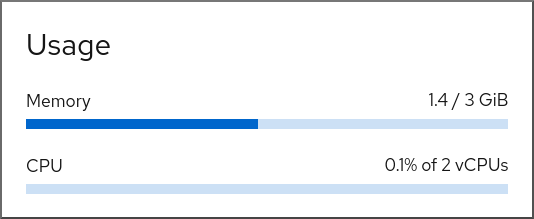

6.2.4. 웹 콘솔에서 가상 머신 리소스 사용량 보기

웹 콘솔을 사용하면 선택한 VM(가상 머신)의 메모리 및 가상 CPU 사용량을 볼 수 있습니다.

사전 요구 사항

- 웹 콘솔 VM 플러그인이 시스템에 설치되어 있습니다.

절차

Virtual Machines (가상 시스템) 인터페이스에서 표시할 정보가 있는 VM을 클릭합니다.

VM의 그래픽 인터페이스에 액세스하기 위한 선택한 VM 및 콘솔 섹션에 대한 기본 정보가 포함된 Overview(개요) 섹션이 포함된 새 페이지가 열립니다.

Usage (사용)로 스크롤합니다.

Usage(사용) 섹션에는 VM의 메모리 및 가상 CPU 사용량에 대한 정보가 표시됩니다.

추가 리소스

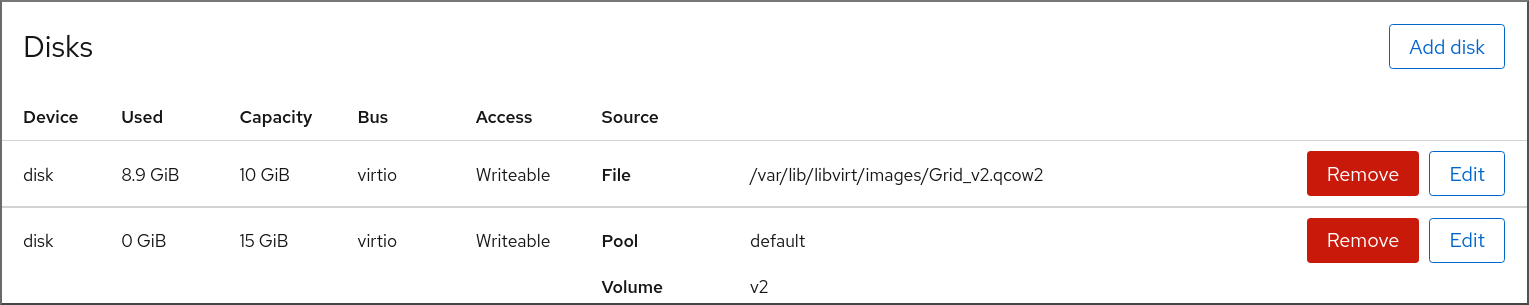

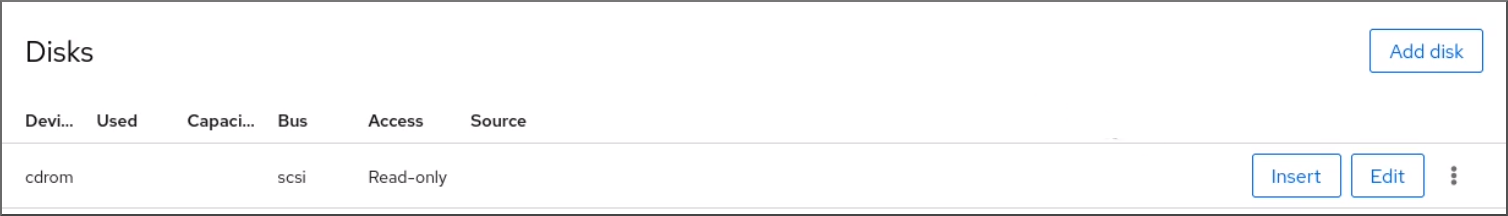

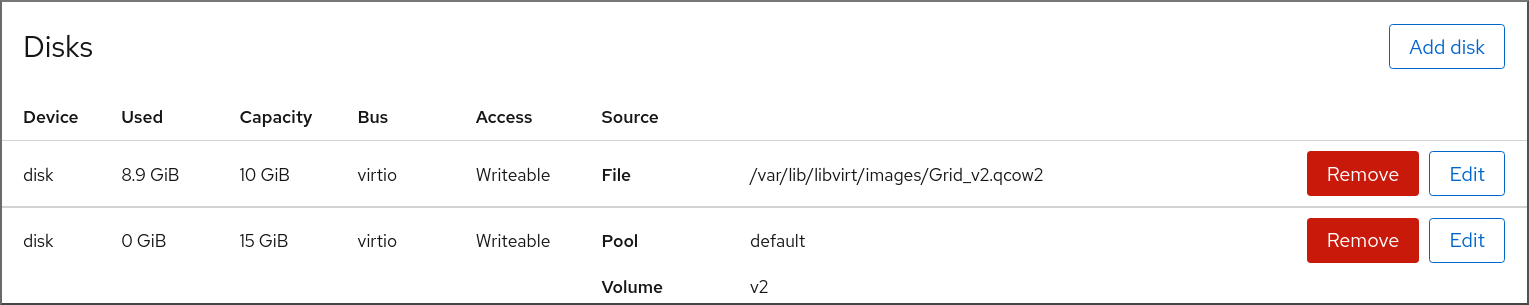

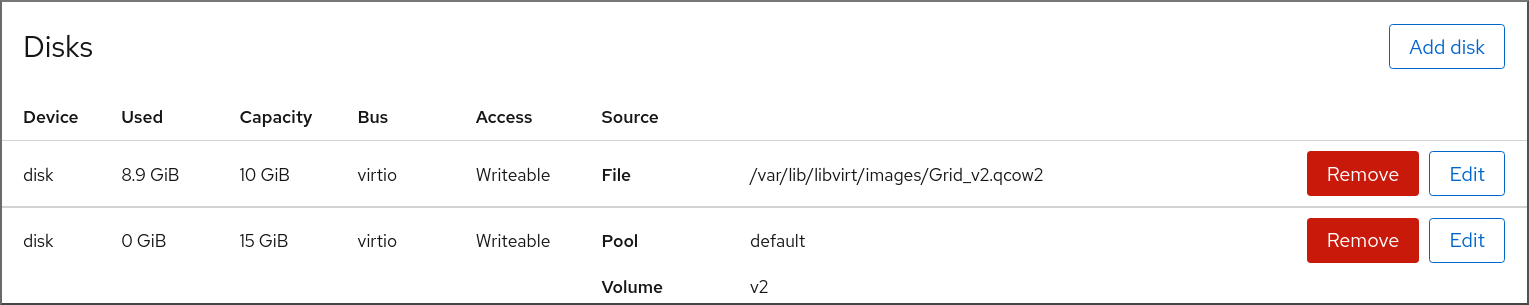

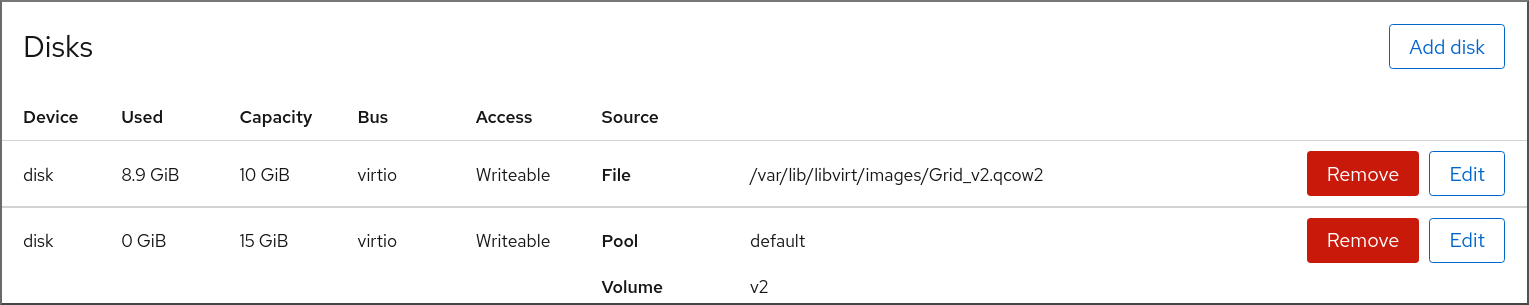

6.2.5. 웹 콘솔에서 가상 머신 디스크 정보 보기

웹 콘솔을 사용하면 선택한 VM(가상 머신)에 할당된 디스크에 대한 자세한 정보를 볼 수 있습니다.

사전 요구 사항

- 웹 콘솔 VM 플러그인이 시스템에 설치되어 있습니다.

절차

보려는 정보를 보여주는 VM을 클릭합니다.

VM의 그래픽 인터페이스에 액세스하기 위한 선택한 VM 및 콘솔 섹션에 대한 기본 정보가 포함된 Overview(개요) 섹션이 포함된 새 페이지가 열립니다.

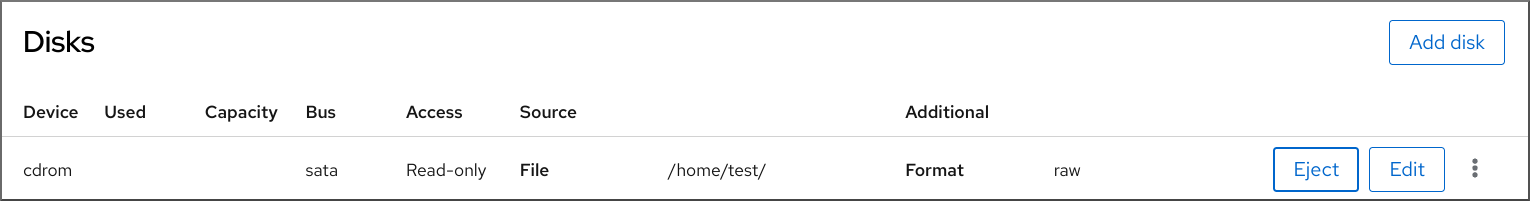

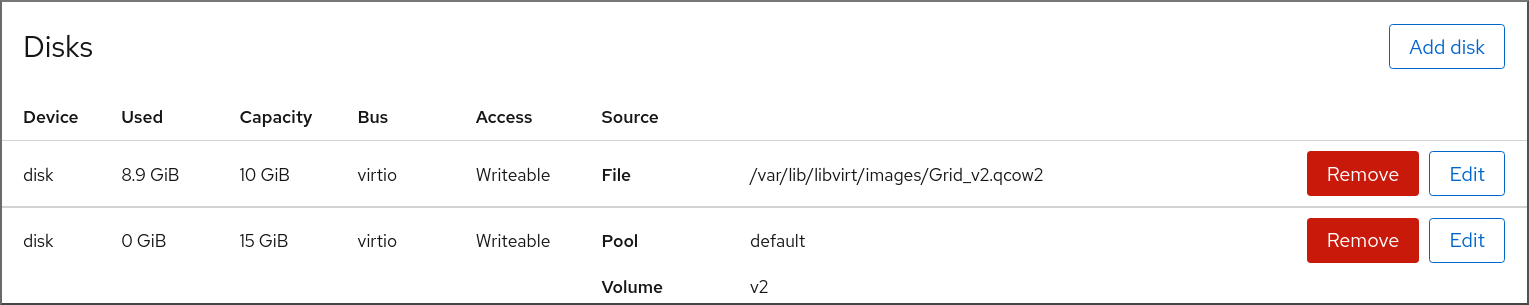

디스크로 스크롤.

Disks(디스크) 섹션에는 VM에 할당된 디스크 정보와 디스크 추가,제거 또는 편집 옵션이 표시됩니다.

이 정보에는 다음이 포함됩니다.

- Device - 디스크의 장치 유형입니다.

- used - 현재 할당된 디스크 양입니다.

- capacity - 스토리지 볼륨의 최대 크기입니다.

- bus - 에뮬레이트된 디스크 장치의 유형입니다.

-

액세스 - 디스크에 쓰기 가능 또는 읽기 전용 인지 여부.

원시디스크의 경우 액세스를 쓰기 가능 및 공유 로 설정할 수도 있습니다. - Source - 디스크 장치 또는 파일입니다.

추가 리소스

6.2.6. 웹 콘솔에서 가상 네트워크 인터페이스 정보 보기 및 편집

RHEL 8 웹 콘솔을 사용하면 선택한 VM(가상 머신)에서 가상 네트워크 인터페이스를 보고 수정할 수 있습니다.

사전 요구 사항

- 웹 콘솔 VM 플러그인이 시스템에 설치되어 있습니다.

절차

Virtual Machines (가상 시스템) 인터페이스에서 표시할 정보가 있는 VM을 클릭합니다.

VM의 그래픽 인터페이스에 액세스하기 위한 선택한 VM 및 콘솔 섹션에 대한 기본 정보가 포함된 Overview(개요) 섹션이 포함된 새 페이지가 열립니다.

네트워크 인터페이스로 스크롤합니다.

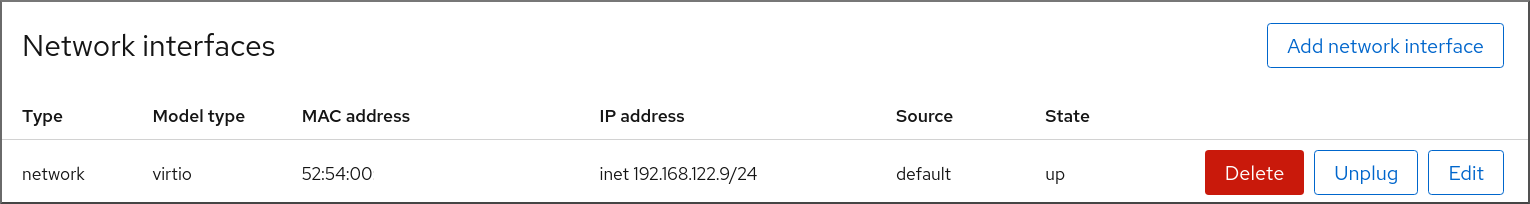

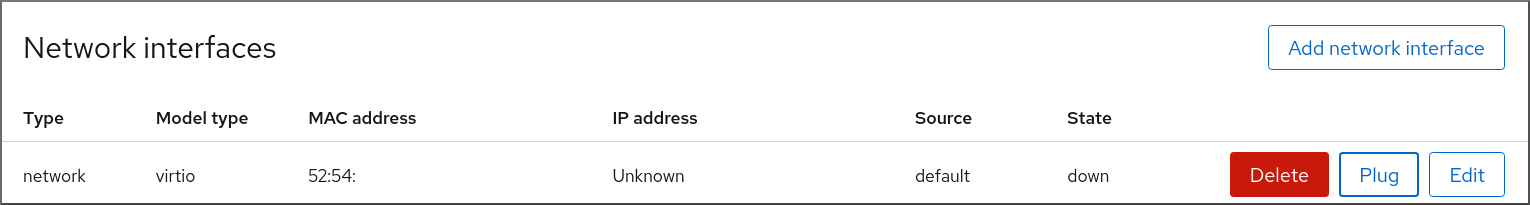

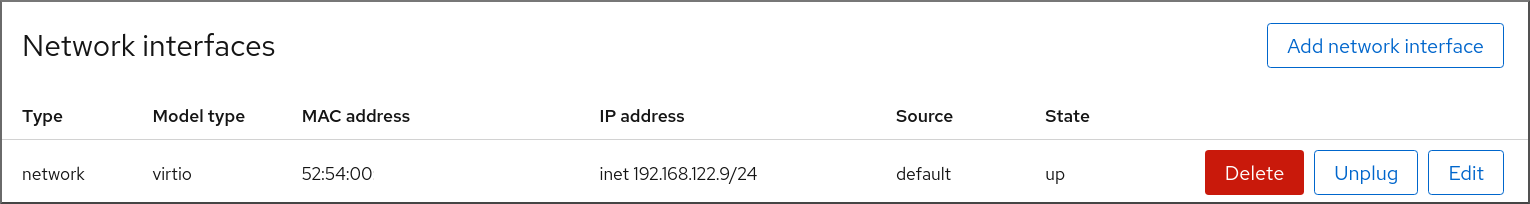

Networks Interfaces(네트워크 인터페이스) 섹션에는 VM에 대해 구성된 가상 네트워크 인터페이스와 네트워크 인터페이스 추가,삭제,편집 또는 연결 해제 옵션이 표시됩니다 .

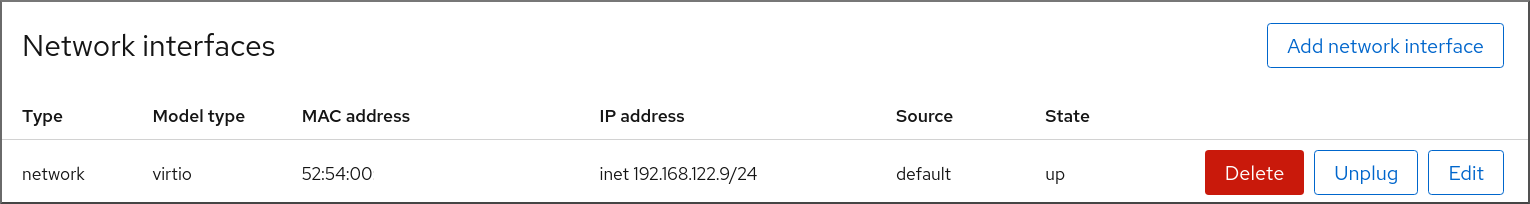

이 정보에는 다음이 포함됩니다.

type - VM의 네트워크 인터페이스 유형입니다. 유형에는 가상 네트워크, LAN에 대한 브리지, 직접 연결이 포함됩니다.

참고RHEL 8 이상에서는 일반 이더넷 연결이 지원되지 않습니다.

- 모델 유형 - 가상 네트워크 인터페이스의 모델입니다.

- MAC 주소 - 가상 네트워크 인터페이스의 MAC 주소입니다.

- IP 주소 - 가상 네트워크 인터페이스의 IP 주소입니다.

- Source - 네트워크 인터페이스의 소스입니다. 이는 네트워크 유형에 따라 다릅니다.

- state - 가상 네트워크 인터페이스의 상태입니다.

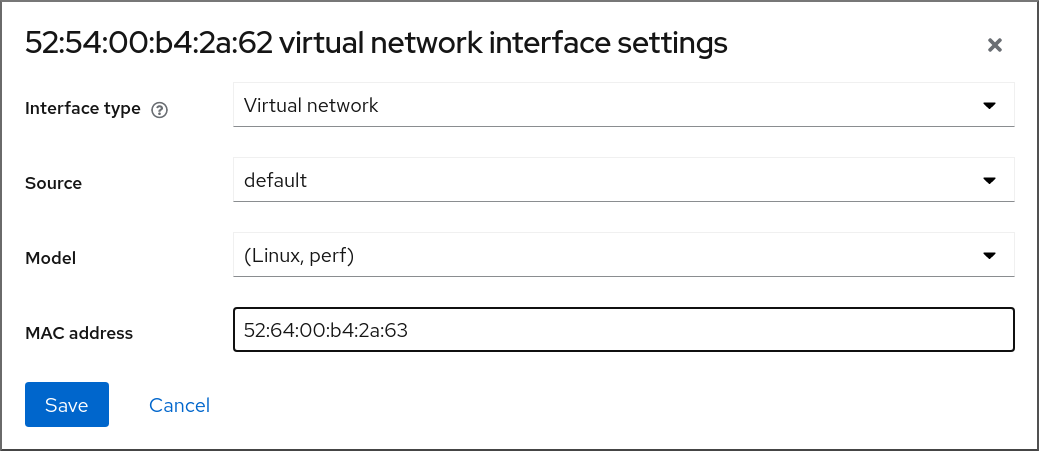

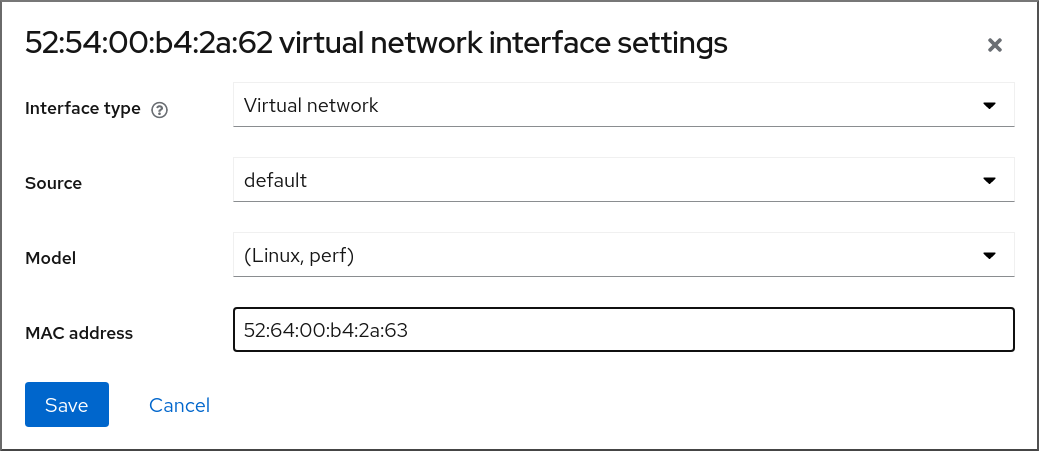

가상 네트워크 인터페이스 설정을 편집하려면 Edit(편집 )를 클릭합니다. Virtual Network Interface Settings(가상 네트워크 인터페이스 설정) 대화 상자가 열립니다.

- 인터페이스 유형, 소스, 모델 또는 MAC 주소를 변경합니다.

저장을 클릭합니다. 네트워크 인터페이스가 수정되었습니다.

참고가상 네트워크 인터페이스 설정에 대한 변경 사항은 VM을 다시 시작한 후에만 적용됩니다.

또한 MAC 주소는 VM이 종료된 경우에만 수정할 수 있습니다.

추가 리소스

6.3. 가상 머신 XML 구성 샘플

VM의 XML 구성( 도메인 XML 이라고도 함)은 VM의 설정 및 구성 요소를 결정합니다. 다음 표는 VM(가상 시스템)의 샘플 XML 구성 섹션과 내용을 설명합니다.

VM의 XML 구성을 얻기 위해 virsh dumpxml 명령 다음에 VM 이름을 사용할 수 있습니다.

# virsh dumpxml testguest1표 6.1. 샘플 XML 구성

| 도메인 XML 섹션 | 설명 |

|---|---|

<domain type='kvm'> <name>Testguest1</name> <uuid>ec6fbaa1-3eb4-49da-bf61-bb02fbec4967</uuid> <memory unit='KiB'>1048576</memory> <currentMemory unit='KiB'>1048576</currentMemory> | Testguest1 이라는 KVM 가상 머신으로, 1024MiB가 할당된 RAM이 할당됩니다. |

<vcpu placement='static'>1</vcpu> | VM은 단일 가상 CPU(vCPU)로 할당됩니다. vCPU 구성에 대한 자세한 내용은 가상 머신 CPU 성능 최적화를 참조하십시오. |

<os> <type arch='x86_64' machine='pc-q35-4.1'>hvm</type> <boot dev='hd'/> </os> | 머신 아키텍처는 AMD64 및 Intel 64 아키텍처로 설정되며 Intel Q35 시스템 유형을 사용하여 기능 호환성을 결정합니다. OS는 하드 디스크 드라이브에서 부팅되도록 설정됩니다. 설치된 OS로 VM을 생성하는 방법에 대한 자세한 내용은 웹 콘솔을 사용하여 가상 머신 생성 및 게스트 운영 체제 설치를 참조하십시오. |

<features> <acpi/> <apic/> </features> | acpi 및 apic 하이퍼바이저 기능은 비활성화되어 있습니다. |

<cpu mode='host-model' check='partial'/> |

기능 XML의 호스트 CPU 정의(virsh |

<clock offset='utc'> <timer name='rtc' tickpolicy='catchup'/> <timer name='pit' tickpolicy='delay'/> <timer name='hpet' present='no'/> </clock> | VM의 가상 하드웨어 클록은 UTC 시간대를 사용합니다. 또한 QEMU 하이퍼바이저와의 동기화를 위해 세 개의 다른 타이머가 설정됩니다. |

<on_poweroff>destroy</on_poweroff> <on_reboot>restart</on_reboot> <on_crash>destroy</on_crash> |

VM의 전원을 끄거나 OS가 예기치 않게 종료되면 |

<pm> <suspend-to-mem enabled='no'/> <suspend-to-disk enabled='no'/> </pm> | 이 VM에 대해 S3 및 S4 ACPI 절전 상태가 비활성화되어 있습니다. |

<devices> <emulator>/usr/bin/qemu-kvm</emulator> <disk type='file' device='disk'> <driver name='qemu' type='qcow2'/> <source file='/var/lib/libvirt/images/Testguest.qcow2'/> <target dev='hda' bus='ide'/> </disk> <disk type='file' device='cdrom'> <driver name='qemu' type='raw'/> <target dev='hdb' bus='ide'/> <readonly/> </disk> |

VM은 에뮬레이션에

첫 번째 디스크는 호스트에 저장된

두 번째 디스크는 가상화된 CD-ROM이며 해당 논리적 장치 이름은 |

<controller type='usb' index='0' model='qemu-xhci' ports='15'/> <controller type='sata' index='0'/> <controller type='pci' index='0' model='pcie-root'/> <controller type='pci' index='1' model='pcie-root-port'> <model name='pcie-root-port'/> <target chassis='1' port='0x10'/> </controller> <controller type='pci' index='2' model='pcie-root-port'> <model name='pcie-root-port'/> <target chassis='2' port='0x11'/> </controller> <controller type='pci' index='3' model='pcie-root-port'> <model name='pcie-root-port'/> <target chassis='3' port='0x12'/> </controller> <controller type='pci' index='4' model='pcie-root-port'> <model name='pcie-root-port'/> <target chassis='4' port='0x13'/> </controller> <controller type='pci' index='5' model='pcie-root-port'> <model name='pcie-root-port'/> <target chassis='5' port='0x14'/> </controller> <controller type='pci' index='6' model='pcie-root-port'> <model name='pcie-root-port'/> <target chassis='6' port='0x15'/> </controller> <controller type='pci' index='7' model='pcie-root-port'> <model name='pcie-root-port'/> <target chassis='7' port='0x16'/> </controller> <controller type='virtio-serial' index='0'/> |

VM은 USB 장치를 연결하는 데 단일 컨트롤러를 사용하고 PCI-Express(PCIe) 장치에 대한 루트 컨트롤러를 사용합니다. 또한 VM이 직렬 콘솔과 같은 다양한 방법으로 호스트와 상호 작용할 수 있는 가상 장치에 대한 자세한 내용은 가상 장치 유형을 참조하십시오. |

<interface type='network'> <mac address='52:54:00:65:29:21'/> <source network='default'/> <model type='rtl8139'/> </interface> |

네트워크 인터페이스는 네트워크 인터페이스 구성에 대한 자세한 내용은 가상 머신 네트워크 성능 최적화를 참조하십시오. |

<serial type='pty'>

<target type='isa-serial' port='0'>

<model name='isa-serial'/>

</target>

</serial>

<console type='pty'>

<target type='serial' port='0'/>

</console>

<channel type='unix'>

<target type='virtio' name='org.qemu.guest_agent.0'/>

<address type='virtio-serial' controller='0' bus='0' port='1'/>

</channel>

<channel type='spicevmc'>

<target type='virtio' name='com.redhat.spice.0'/>

<address type='virtio-serial' controller='0' bus='0' port='2'/>

</channel>

|

VM과 상호 작용하는 방법에 대한 자세한 내용은 웹 콘솔을 사용하여 가상 머신 상호 작용을 참조하십시오. |

<input type='tablet' bus='usb'> <address type='usb' bus='0' port='1'/> </input> <input type='mouse' bus='ps2'/> <input type='keyboard' bus='ps2'/> | VM은 태블릿 입력을 수신하도록 설정된 가상 usb 포트와 마우스 및 키보드 입력을 수신하도록 설정된 가상 ps2 포트를 사용합니다. 이 설정은 자동으로 설정되며 이러한 설정을 변경하는 것은 권장되지 않습니다. |

<graphics type='spice' autoport='yes' listen='127.0.0.1'> <listen type='address' address='127.0.0.1'/> <image compression='off'/> </graphics> <graphics type='vnc' port='-1' autoport='yes' listen='127.0.0.1'> <listen type='address' address='127.0.0.1'/> </graphics> |

VM은 그래픽 출력을 렌더링하기 위해 |

<sound model='ich6'> <address type='pci' domain='0x0000' bus='0x00' slot='0x04' function='0x0'/> </sound> <video> <model type='qxl' ram='65536' vram='65536' vgamem='16384' heads='1' primary='yes'/> <address type='pci' domain='0x0000' bus='0x00' slot='0x02' function='0x0'/> </video> |

|

<redirdev bus='usb' type='spicevmc'> <address type='usb' bus='0' port='1'/> </redirdev> <redirdev bus='usb' type='spicevmc'> <address type='usb' bus='0' port='2'/> </redirdev> <memballoon model='virtio'> <address type='pci' domain='0x0000' bus='0x00' slot='0x07' function='0x0'/> </memballoon> </devices> </domain> | VM에는 USB 장치를 원격으로 연결하는 두 개의 리디렉션이 있으며 메모리 증대가 켜집니다. 이 설정은 자동으로 설정되며 이러한 설정을 변경하는 것은 권장되지 않습니다. |

7장. 가상 머신 저장 및 복원

시스템 리소스를 확보하기 위해 해당 시스템에서 실행 중인 VM(가상 머신)을 종료할 수 있습니다. 그러나 VM이 다시 필요한 경우 게스트 운영 체제(OS)를 부팅하고 애플리케이션을 다시 시작해야 합니다. 이 경우 상당한 시간이 걸릴 수 있습니다. 이 다운타임을 줄이고 VM 워크로드가 더 빨리 실행되도록 하려면 저장 및 복원 기능을 사용하여 OS 종료 및 부팅 시퀀스를 완전히 방지할 수 있습니다.

이 섹션에서는 VM 저장 및 전체 VM 부팅 없이 동일한 상태로 복원하는 방법에 대한 정보를 제공합니다.

7.1. 가상 머신의 저장 및 복원 방법

VM(가상 시스템)을 저장하면 호스트의 디스크에 메모리 및 장치 상태가 저장되고 VM 프로세스가 즉시 중지됩니다. 실행 중 또는 일시 중지된 상태인 VM을 저장할 수 있으며 복원 시 VM이 해당 상태로 돌아갑니다.

이 프로세스는 디스크 공간을 대신하여 호스트 시스템의 RAM 및 CPU 리소스를 사용 가능하게 하므로 호스트 시스템 성능이 향상될 수 있습니다. 게스트 OS를 부팅할 필요가 없으므로 VM을 복원하면 부팅 기간이 길어집니다.

VM을 저장하려면 CLI(명령줄 인터페이스)를 사용할 수 있습니다. 자세한 내용은 명령줄 인터페이스를 사용하여 가상 머신 저장을 참조하십시오.

7.2. 명령줄 인터페이스를 사용하여 가상 머신 저장

VM(가상 머신)과 해당 현재 상태를 호스트의 디스크에 저장할 수 있습니다. 예를 들어 호스트의 리소스를 다른 용도로 사용해야 하는 경우 유용합니다. 그런 다음 저장된 VM을 이전 실행 상태로 신속하게 복원할 수 있습니다.

명령줄을 사용하여 VM을 저장하려면 아래 절차를 따르십시오.

사전 요구 사항

- VM 및 해당 구성을 저장할 수 있는 디스크 공간이 충분한지 확인합니다. VM에서 점유하는 공간은 해당 VM에 할당된 RAM의 양에 따라 다릅니다.

- VM이 영구적인지 확인합니다.

- 선택 사항: 필요한 경우 VM에서 중요한 데이터를 백업합니다.

절차

virsh managedsave유틸리티를 사용합니다.예를 들어 다음 명령은 demo-guest1 VM을 중지하고 해당 구성을 저장합니다.

# virsh managedsave demo-guest1 Domain 'demo-guest1' saved by libvirt저장된 VM 파일은 기본적으로 demo-guest1.save로 /var/lib/libvirt/qemu/save 디렉터리에 있습니다.

다음에 VM이 시작되면 위의 파일에서 저장된 상태를 자동으로 복원합니다.

검증

저장이 활성화된 VM을 나열합니다. 다음 예에서는 저장된 VM에 관리 저장 이 활성화되었습니다.

# virsh list --managed-save --all Id Name State ---------------------------------------------------- - demo-guest1 saved - demo-guest2 shut off관리형 저장 이미지가 있는 VM을 나열하려면 다음을 수행합니다.

# virsh list --with-managed-save --all Id Name State ---------------------------------------------------- - demo-guest1 shut off종료된 상태인 VM을 나열하려면 명령에

--all또는--inactive옵션을 사용해야 합니다.

문제 해결

- 저장된 VM 파일이 손상되거나 읽을 수 없게 되면 VM을 복원하면 표준 VM 부팅이 시작됩니다.

추가 리소스

-

virsh managedsave --help명령 - 명령줄 인터페이스를 사용하여 저장된 VM 복원

- 웹 콘솔을 사용하여 저장된 VM 복원

7.3. 명령줄 인터페이스를 사용하여 가상 머신 시작

CLI(명령줄 인터페이스)를 사용하여 종료한 VM(가상 머신)을 시작하거나 저장된 VM을 복원할 수 있습니다. CLI를 사용하면 로컬 및 원격 VM을 모두 시작할 수 있습니다.

사전 요구 사항

- 이미 정의된 비활성 VM입니다.

- VM의 이름입니다.

원격 VM의 경우:

- VM이 있는 호스트의 IP 주소입니다.

- 호스트에 대한 루트 액세스 권한.

절차

로컬 VM의 경우

virsh start유틸리티를 사용합니다.예를 들어 다음 명령은 demo-guest1 VM을 시작합니다.

# virsh start demo-guest1 Domain 'demo-guest1' started원격 호스트에 있는 VM의 경우 호스트에 대한 QEMU+SSH 연결과 함께

virsh start유틸리티를 사용합니다.예를 들어 다음 명령은 192.0.2.1 호스트에서 demo-guest1 VM을 시작합니다.

# virsh -c qemu+ssh://root@192.0.2.1/system start demo-guest1 root@192.0.2.1's password: Domain 'demo-guest1' started

추가 리소스

-

virsh start --help명령 - 원격 가상화 호스트에 쉽게 액세스 가능

- 호스트가 시작될 때 자동으로 가상 머신 시작

7.4. 웹 콘솔을 사용하여 가상 머신 시작

VM(가상 머신)이 shut off 상태인 경우 RHEL 8 웹 콘솔을 사용하여 시작할 수 있습니다. 호스트가 시작될 때 VM이 자동으로 시작하도록 구성할 수도 있습니다.

사전 요구 사항

- 웹 콘솔 VM 플러그인이 시스템에 설치되어 있습니다.

- 이미 정의된 비활성 VM입니다.

- VM의 이름입니다.

절차

Virtual Machines (가상 시스템) 인터페이스에서 시작할 VM을 클릭합니다.

선택한 VM에 대한 자세한 정보와 VM 종료 및 삭제를 위한 컨트롤이 포함된 새 페이지가 열립니다.

Run(실행)을 클릭합니다.

VM이 시작되고 콘솔 또는 그래픽 출력에 연결할 수 있습니다.

선택 사항: 호스트가 시작될 때 자동으로 시작되도록 VM을 구성하려면 Overview 섹션의

Autostart확인란을 전환합니다.libvirt에서 관리하지 않는 네트워크 인터페이스를 사용하는 경우 systemd 구성도 변경해야 합니다. 그렇지 않으면 영향을 받는 VM이 시작되지 못할 수 있습니다. 호스트가 시작될 때 자동으로 가상 시스템 시작을 참조하십시오.

8장. 가상 머신 복제

특정 속성 집합을 사용하여 새 VM(가상 머신)을 신속하게 생성하려면 기존 VM을 복제할 수 있습니다.

복제는 스토리지에 자체 디스크 이미지를 사용하는 새 VM을 생성하지만 대부분의 복제본 구성 및 저장된 데이터는 소스 VM과 동일합니다. 따라서 각 VM을 개별적으로 최적화할 필요 없이 특정 작업에 최적화된 여러 VM을 준비할 수 있습니다.

8.1. 가상 머신 복제의 작동 방식

VM(가상 시스템)을 복제하면 소스 VM과 해당 디스크 이미지의 XML 구성을 복사하고 구성을 조정하여 새 VM의 고유성을 보장합니다. 여기에는 VM의 이름을 변경하고 디스크 이미지 복제본을 사용하는지 확인하는 작업이 포함됩니다. 하지만 복제본의 가상 디스크에 저장된 데이터는 소스 VM과 동일합니다.

이 프로세스는 새 VM을 만들고 게스트 운영 체제로 설치하는 것보다 빠르며 특정 구성 및 컨텐츠로 VM을 신속하게 생성하는 데 사용할 수 있습니다.

VM 복제본을 여러 개 생성하려는 경우 먼저 다음을 포함하지 않는 VM 템플릿을 생성합니다.

- 복제본이 올바르게 작동하지 않도록 할 수 있는 영구 네트워크 MAC 구성과 같은 고유한 설정입니다.

- SSH 키 및 암호 파일과 같은 중요한 데이터.

자세한 내용은 가상 머신 템플릿 생성을 참조하십시오.

8.2. 가상 머신 템플릿 생성

여러 VM(가상 머신)에서 올바르게 작동하는 복제본을 생성하려면 SSH 키 또는 영구 네트워크 MAC 구성과 같이 소스 VM에 고유한 정보와 구성을 제거할 수 있습니다. 그러면 VM 복제본을 쉽고 안전하게 생성하는 데 사용할 수 있는 VM 템플릿 이 생성됩니다.

virt-sysprep 유틸리티를 사용하여 VM 템플릿 을 생성하거나 요구 사항에 따라 수동으로 생성할 수 있습니다.

8.2.1. virt-sysprep을 사용하여 가상 머신 템플릿 생성

기존 VM(가상 머신)에서 복제 템플릿을 생성하려면 virt-sysprep 유틸리티를 사용할 수 있습니다. 이렇게 하면 특정 네트워크 설정 또는 시스템 등록 메타데이터와 같이 복제본이 잘못될 수 있는 특정 구성이 제거됩니다. 결과적으로 virt-sysprep 은 VM의 복제본을 보다 효율적으로 생성하고 복제본이 보다 안정적으로 작동하도록 합니다.

사전 요구 사항

virt-sysprep유틸리티를 포함하는libguestfs-tools-c패키지가 호스트에 설치됩니다.# yum install libguestfs-tools-c- 템플릿으로 예정된 소스 VM이 종료됩니다.

소스 VM의 디스크 이미지가 있는 위치를 알고 VM의 디스크 이미지 파일의 소유자입니다.

libvirt의 시스템 연결에 생성된 VM의 디스크 이미지는

/var/lib/libvirt/images디렉터리에 있으며 기본적으로 root 사용자가 소유합니다.# ls -la /var/lib/libvirt/images -rw-------. 1 root root 9665380352 Jul 23 14:50 a-really-important-vm.qcow2 -rw-------. 1 root root 8591507456 Jul 26 2017 an-actual-vm-that-i-use.qcow2 -rw-------. 1 root root 8591507456 Jul 26 2017 totally-not-a-fake-vm.qcow2 -rw-------. 1 root root 10739318784 Sep 20 17:57 another-vm-example.qcow2- 선택 사항: 소스 VM 디스크의 중요한 데이터가 백업되었습니다. 소스 VM을 그대로 유지하려면 먼저 복제 한 후 복제본을 템플릿으로 전환합니다.

절차

VM의 디스크 이미지 소유자로 로그인했는지 확인합니다.

# whoami root선택 사항: VM의 디스크 이미지를 복사합니다.

# cp /var/lib/libvirt/images/a-really-important-vm.qcow2 /var/lib/libvirt/images/a-really-important-vm-original.qcow2나중에 VM이 템플릿으로 성공적으로 변경되었는지 확인하는 데 사용됩니다.

다음 명령을 사용하고 /var/lib/libvirt/images/a-really-important-vm.qcow2 를 소스 VM의 디스크 이미지 경로로 바꿉니다.

# virt-sysprep -a /var/lib/libvirt/images/a-really-important-vm.qcow2 [ 0.0] Examining the guest ... [ 7.3] Performing "abrt-data" ... [ 7.3] Performing "backup-files" ... [ 9.6] Performing "bash-history" ... [ 9.6] Performing "blkid-tab" ... [...]

검증

프로세스가 성공했는지 확인하려면 수정된 디스크 이미지를 원래 이미지와 비교합니다. 다음 예제에서는 템플릿이 성공적으로 생성되었음을 보여줍니다.

# virt-diff -a /var/lib/libvirt/images/a-really-important-vm-orig.qcow2 -A /var/lib/libvirt/images/a-really-important-vm.qcow2 - - 0644 1001 /etc/group- - - 0000 797 /etc/gshadow- = - 0444 33 /etc/machine-id [...] - - 0600 409 /home/username/.bash_history - d 0700 6 /home/username/.ssh - - 0600 868 /root/.bash_history [...]

추가 리소스

-

virt-sysprep도움말 페이지의 OPERATIONS 섹션 - 명령줄 인터페이스를 사용하여 가상 머신 복제

8.2.2. 수동으로 가상 머신 템플릿 생성

기존 VM(가상 시스템)에서 템플릿을 생성하려면 게스트 VM을 수동으로 재설정하거나 구성 해제하여 복제를 준비할 수 있습니다.

사전 요구 사항

소스 VM의 디스크 이미지 위치를 알고 있고 VM의 디스크 이미지 파일의 소유자임을 확인합니다.

libvirt의 시스템 연결에 생성된 VM의 디스크 이미지는 기본적으로

/var/lib/libvirt/images디렉터리에 있으며 root 사용자가 소유합니다.# ls -la /var/lib/libvirt/images -rw-------. 1 root root 9665380352 Jul 23 14:50 a-really-important-vm.qcow2 -rw-------. 1 root root 8591507456 Jul 26 2017 an-actual-vm-that-i-use.qcow2 -rw-------. 1 root root 8591507456 Jul 26 2017 totally-not-a-fake-vm.qcow2 -rw-------. 1 root root 10739318784 Sep 20 17:57 another-vm-example.qcow2- VM이 종료되었는지 확인합니다.

- 선택 사항: VM 디스크의 중요한 데이터가 모두 백업되었습니다. 소스 VM을 그대로 유지하려면 먼저 복제하고 복제본을 편집하여 템플릿을 생성합니다.

절차

복제할 VM을 구성합니다.

- 복제본에 필요한 소프트웨어를 설치합니다.

- 운영 체제에 대해 고유하지 않은 설정을 구성합니다.

- 고유하지 않은 애플리케이션 설정을 구성합니다.

네트워크 구성을 제거합니다.

다음 명령을 사용하여 영구 udev 규칙을 제거합니다.

# rm -f /etc/udev/rules.d/70-persistent-net.rules참고udev 규칙이 제거되지 않은 경우 첫 번째 NIC 이름은 eth

0 대신이 될 수 있습니다.eth1다음과 같이

/etc/sysconfig/network-scripts/ifcfg-eth[x]를 편집하여 ifcfg 스크립트에서 고유한 네트워크 세부 정보를 제거합니다.HWADDR 및 Static 행을 제거합니다.

참고HWADDR이 새 게스트의 MAC 주소와 일치하지 않으면

ifcfg가 무시됩니다.DEVICE=eth[x] BOOTPROTO=none ONBOOT=yes #NETWORK=192.0.2.0 <- REMOVE #NETMASK=255.255.255.0 <- REMOVE #IPADDR=192.0.2.1 <- REMOVE #HWADDR=xx:xx:xx:xx:xx <- REMOVE #USERCTL=no <- REMOVE # Remove any other *unique or non-desired settings, such as UUID.*DHCP를 구성하지만 HWADDR 또는 기타 고유한 정보는 포함하지 마십시오.

DEVICE=eth[x] BOOTPROTO=dhcp ONBOOT=yes

시스템에 있는 경우 다음 파일에 동일한 내용이 포함되어 있는지 확인합니다.

-

/etc/sysconfig/networking/devices/ifcfg-eth[x] /etc/sysconfig/networking/profiles/default/ifcfg-eth[x]참고NetworkManager또는 VM과 함께 특별한 설정을 사용한 경우 추가 고유 정보가ifcfg스크립트에서 제거되었는지 확인합니다.

-

등록 세부 정보 삭제:

RHN(Red Hat Network)에 등록된 VM의 경우:

# rm /etc/sysconfig/rhn/systemidRHSM(Red Hat Subscription Manager)에 등록된 VM의 경우:

원래 VM을 사용하지 않으려는 경우:

# subscription-manager unsubscribe --all # subscription-manager unregister # subscription-manager clean원래 VM을 사용하려는 경우:

# subscription-manager clean참고원래 RHSM 프로필은 ID 코드와 함께 포털에 유지됩니다. 다음 명령을 사용하여 VM에서 RHSM 등록을 복제한 후 다시 활성화합니다.

# subscription-manager register --consumerid=71rd64fx-6216-4409-bf3a-e4b7c7bd8ac9

다른 고유한 세부 정보 제거:

SSH 공개 및 개인 키 쌍을 제거합니다.

# rm -rf /etc/ssh/ssh_host_exampleLVM 장치의 구성을 제거합니다.

# rm /etc/lvm/devices/system.devices- 여러 시스템에서 실행되는 경우 충돌을 일으킬 수 있는 다른 애플리케이션 관련 식별자 또는 구성을 제거합니다.

gnome-initial-setup-done파일을 제거하여 다음 부팅 시 구성 마법사를 실행하도록 VM을 구성합니다.# rm ~/.config/gnome-initial-setup-done참고다음 부팅에서 실행되는 마법사는 VM에서 제거된 구성에 따라 다릅니다. 또한 복제가 처음 부팅되면 호스트 이름을 변경하는 것이 좋습니다.

8.3. 명령줄 인터페이스를 사용하여 가상 머신 복제

테스트의 경우 특정 속성 세트로 새 VM(가상 머신)을 생성하려면 CLI를 사용하여 기존 VM을 복제할 수 있습니다.

사전 요구 사항

- source VM이 종료되었습니다.

- 복제된 디스크 이미지를 저장할 수 있는 디스크 공간이 충분한지 확인합니다.

- 선택 사항: 여러 VM 복제본을 생성할 때 소스 VM에서 고유한 데이터 및 설정을 제거하여 복제된 VM이 제대로 작동하는지 확인합니다. 자세한 내용은 가상 머신 템플릿 생성을 참조하십시오.

절차

사용자 환경과 사용 사례에 적합한 옵션과 함께

virt-clone유틸리티를 사용합니다.샘플 사용 사례

다음 명령은

example-VM-1이라는 로컬 VM을 복제하고example-VM-1-cloneVM을 생성합니다. 또한 원래 VM의 디스크 이미지와 동일한 위치에example-VM-1-clone.qcow2디스크 이미지를 생성하고 할당합니다.# virt-clone --original example-VM-1 --auto-clone Allocating 'example-VM-1-clone.qcow2' | 50.0 GB 00:05:37 Clone 'example-VM-1-clone' created successfully.다음 명령은

example-VM-2라는 VM을 복제하고example-VM-3이라는 로컬 VM을 생성합니다. 이 VM-3은example-VM-2디스크 중 두 개만 사용합니다.# virt-clone --original example-VM-2 --name example-VM-3 --file /var/lib/libvirt/images/disk-1-example-VM-2.qcow2 --file /var/lib/libvirt/images/disk-2-example-VM-2.qcow2 Allocating 'disk-1-example-VM-2-clone.qcow2' | 78.0 GB 00:05:37 Allocating 'disk-2-example-VM-2-clone.qcow2' | 80.0 GB 00:05:37 Clone 'example-VM-3' created successfully.다른 호스트로 VM을 복제하려면 로컬 호스트에서 VM 정의를 해제하지 않고 VM을 마이그레이션합니다. 예를 들어 다음 명령은 이전에 생성된

example-VM-3VM을 로컬 디스크를 포함하여192.0.2.1원격 시스템에 복제합니다.192.0.2.1에 대해 이러한 명령을 실행하려면 root 권한이 필요합니다.# virsh migrate --offline --persistent example-VM-3 qemu+ssh://root@192.0.2.1/system root@192.0.2.1's password: # scp /var/lib/libvirt/images/<disk-1-example-VM-2-clone>.qcow2 root@192.0.2.1/<user@remote_host.com>://var/lib/libvirt/images/ # scp /var/lib/libvirt/images/<disk-1-example-VM-2-clone>.qcow2 root@192.0.2.1/<user@remote_host.com>://var/lib/libvirt/images/

검증

VM이 성공적으로 복제되었으며 올바르게 작동하는지 확인하려면 다음을 수행하십시오.

호스트의 VM 목록에 복제본이 추가되었는지 확인합니다.

# virsh list --all Id Name State --------------------------------------- - example-VM-1 shut off - example-VM-1-clone shut off복제본을 시작하고 부팅 여부를 관찰합니다.

# virsh start example-VM-1-clone Domain 'example-VM-1-clone' started

추가 리소스

-

virt-clone(1)매뉴얼 페이지 - 가상 머신 마이그레이션

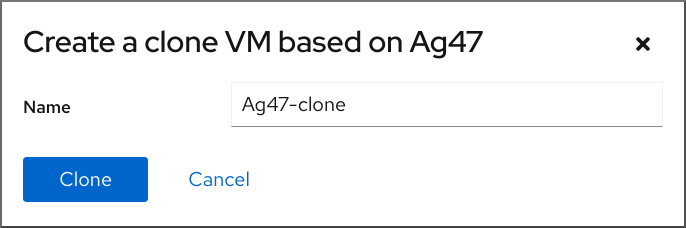

8.4. 웹 콘솔을 사용하여 가상 머신 복제

특정 속성 세트를 사용하여 새 VM(가상 머신)을 생성하려면 웹 콘솔을 사용하여 이전에 구성한 VM을 복제할 수 있습니다.

VM을 복제하면 해당 VM과 연결된 디스크도 복제됩니다.

사전 요구 사항

- 웹 콘솔 VM 플러그인이 시스템에 설치되어 있습니다.

- 복제하려는 VM이 종료되었는지 확인합니다.

절차

웹 콘솔의 Virtual Machines(가상 시스템) 인터페이스에서 복제할 VM 의 Menu(메뉴) 단추를 클릭합니다.

다양한 VM 작업에 대한 컨트롤이 포함된 드롭다운 메뉴가 나타납니다.

Clone(복제 )을 클릭합니다.

Create a clone VM(복제 VM 만들기) 대화 상자가 표시됩니다.

- 선택 사항: VM 복제의 새 이름을 입력합니다.

Clone(복제 )을 클릭합니다.

소스 VM을 기반으로 새 VM이 생성됩니다.

검증

- 복제된 VM이 호스트에서 사용 가능한 VM 목록에 표시되는지 확인합니다.

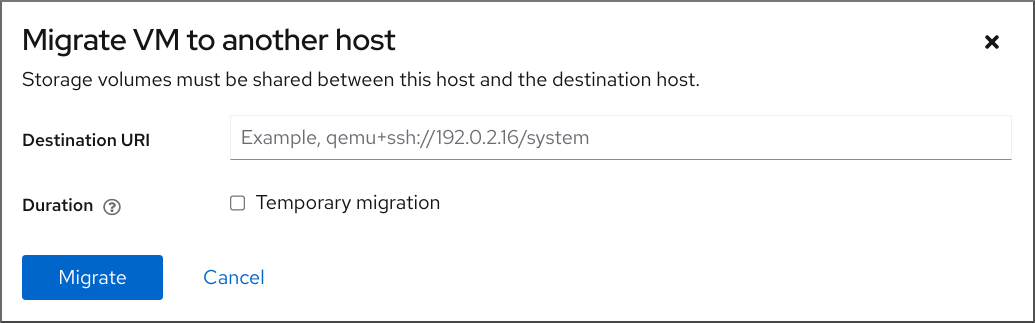

9장. 가상 머신 마이그레이션

VM(가상 머신)의 현재 호스트가 적합하지 않거나 더 이상 사용할 수 없는 경우 또는 호스팅 워크로드를 재배포하려는 경우 VM을 다른 KVM 호스트로 마이그레이션할 수 있습니다.

9.1. 가상 머신 마이그레이션 방법

VM(가상 시스템) 마이그레이션의 필수 부분은 VM의 XML 구성을 다른 호스트 시스템에 복사하는 것입니다. 마이그레이션된 VM이 종료되지 않은 경우 마이그레이션은 VM의 메모리 및 가상화된 장치의 상태도 대상 호스트 시스템으로 전송합니다. VM이 대상 호스트에서 작동 상태로 유지하려면 VM의 디스크 이미지를 계속 사용할 수 있어야 합니다.

기본적으로 마이그레이션된 VM은 대상 호스트에서 일시적이며 소스 호스트에도 정의되어 있습니다.

실시간 또는 실시간 이 아닌 마이그레이션을 사용하여 실행 중인 VM을 마이그레이션할 수 있습니다. 가상 머신 종료를 마이그레이션하려면 오프라인 마이그레이션을 사용해야 합니다. 자세한 내용은 다음 표를 참조하십시오.

표 9.1. VM 마이그레이션 유형

| 마이그레이션 유형 | 설명 | 사용 사례 | 스토리지 요구사항 |

|---|---|---|---|

| 실시간 마이그레이션 | KVM이 VM의 메모리 페이지를 대상 호스트로 전송하는 동안 VM은 소스 호스트 시스템에서 계속 실행됩니다. 마이그레이션이 거의 완료되면 KVM은 VM을 매우 간단하게 일시 중지하고 대상 호스트에서 다시 시작합니다. | 지속적인 가동 시간이 필요한 VM에 유용합니다. 그러나 메모리 페이지를 수정하는 VM은 많은 I/O 부하가 있는 VM과 같이 메모리 페이지를 이전할 수 있으며 실시간이 아닌 마이그레이션을 대신 사용해야 합니다. | VM의 디스크 이미지는 공유 네트워크에 있어야 하며 소스 호스트와 대상 호스트에 모두 액세스할 수 있어야 합니다. |

| 실시간이 아닌 마이그레이션 | VM을 일시 중지하고 해당 구성과 해당 메모리를 대상 호스트에 복사한 다음 VM을 다시 시작합니다. | VM에 대한 다운타임을 생성하지만 실시간 마이그레이션보다 일반적으로 더 안정적입니다. 메모리 로드가 많은 VM에 권장됩니다. | VM의 디스크 이미지는 공유 네트워크에 있어야 하며 소스 호스트와 대상 호스트에 모두 액세스할 수 있어야 합니다. |

| 오프라인 마이그레이션 | VM의 구성을 대상 호스트로 이동 | VM을 종료하는 경우 VM을 종료하고 VM을 종료해도 워크로드가 중단되지 않습니다. | VM의 디스크 이미지는 공유 네트워크에서 사용할 수 없으며 대신 대상 호스트로 수동으로 복사하거나 이동할 수 있습니다. |

실시간 마이그레이션과 실시간이 아닌 마이그레이션 을 결합할 수도 있습니다. 예를 들어 매우 많은 vCPU 또는 많은 양의 메모리를 사용하는 VM을 실시간으로 마이그레이션하여 마이그레이션이 완료되지 않는 것이 좋습니다. 이러한 시나리오에서는 소스 VM을 일시 중단할 수 있습니다. 이렇게 하면 추가 더티 메모리 페이지가 생성되지 않으므로 마이그레이션이 완료될 가능성이 훨씬 높아집니다. 게스트 워크로드 및 마이그레이션 중 정적 페이지 수에 따라 하이브리드 마이그레이션으로 인해 실시간이 아닌 마이그레이션보다 다운 타임이 크게 줄어들 수 있습니다.

9.2. 가상 머신 마이그레이션의 이점

VM(가상 머신)을 마이그레이션하는 데 유용할 수 있습니다.

- 로드 밸런싱

- VM은 호스트가 과부하가 발생하거나 다른 호스트가 활용도가 낮은 경우 사용량이 낮은 시스템을 호스트하도록 이동할 수 있습니다.

- 하드웨어 독립

- 호스트 시스템에서 하드웨어 장치를 업그레이드, 추가 또는 제거해야 하는 경우 VM을 다른 호스트로 안전하게 재배치할 수 있습니다. 즉, VM에서 하드웨어 개선에 다운타임이 발생하지 않습니다.

- 에너지 절약

- VM을 다른 호스트에 재배포할 수 있으며, 로드되지 않은 호스트 시스템의 전원이 꺼져 사용 기간이 짧은 동안 에너지 절약 및 비용을 절감할 수 있습니다.

- 지리적 마이그레이션

- VM은 대기 시간을 단축하거나 다른 이유로 필요한 경우 다른 물리적 위치로 이동할 수 있습니다.

9.3. 가상 머신 마이그레이션의 제한 사항

RHEL 8에서 가상 머신(VM)을 마이그레이션하기 전에 마이그레이션의 제한 사항을 알고 있어야 합니다.

- 실시간 스토리지 마이그레이션은 RHEL 8에서 수행할 수 없지만 VM의 전원이 꺼진 동안 스토리지를 마이그레이션할 수 있습니다. 실시간 스토리지 마이그레이션은 Red Hat Virtualization 에서 사용할 수 있습니다.

-

libvirt의 세션 연결 또는 세션 연결 로 VM을 마이그레이션하는 것은 신뢰할 수 없으므로 권장되지 않는 것이 좋습니다. 마이그레이션된 경우 특정 기능 및 구성을 사용하는 VM이 제대로 작동하지 않거나 마이그레이션이 실패합니다. 이러한 기능은 다음과 같습니다.

- 장치 통과

- SR-IOV 장치 할당

- vGPU와 같은 중재된 장치

- NUMA(Non-Uniform Memory Access) 고정 고정을 사용하는 호스트 간의 마이그레이션은 호스트에 유사한 토폴로지가 있는 경우에만 작동합니다. 그러나 워크로드 실행에 대한 성능은 마이그레이션의 영향을 받을 수 있습니다.

소스 VM과 대상 VM의 에뮬레이션된 CPU는 동일해야 합니다. 그렇지 않으면 마이그레이션이 실패할 수 있습니다. 다음 CPU 관련 영역에 있는 VM 간의 차이로 인해 마이그레이션에 문제가 발생할 수 있습니다.

CPU 모델

- x86-64 명령을 공유하더라도 Intel 64 호스트와 AMD64 호스트 간에 마이그레이션하는 것은 지원되지 않습니다.

- 다른 CPU 모델을 사용하여 호스트로 마이그레이션한 후 VM이 올바르게 작동하는지 확인하는 단계는 가상 머신 마이그레이션에 대한 호스트 CPU 호환성 확인을 참조하십시오.

- 펌웨어 설정

- 마이크로 코드 버전

- BIOS 버전

- BIOS 설정

- QEMU 버전

- 커널 버전

- 경우에 따라 1TB 이상의 메모리를 사용하는 VM을 실시간으로 마이그레이션할 수 있습니다. 이 문제를 방지하거나 해결하는 방법에 대한 자세한 내용은 VM 실시간 마이그레이션에 완료하지 않고 오랜 시간이 걸립니다.

9.4. 가상 머신 마이그레이션을 위한 호스트 CPU 호환성 확인

마이그레이션된 VM(가상 머신)이 대상 호스트에서 올바르게 작동하려면 소스의 CPU와 대상 호스트가 호환 가능해야 합니다. 이 경우 마이그레이션을 시작하기 전에 공통 CPU 기준을 계산합니다.