Red Hat Training

A Red Hat training course is available for Red Hat Enterprise Linux

스토리지 관리 가이드

RHEL 7에서 단일 노드 스토리지 배포 및 구성

초록

1장. 개요

1.1. Red Hat Enterprise Linux 7의 새로운 기능 및 기능 개선

1.1.1. ecryptfs가 포함되지 않음

1.1.2. 시스템 스토리지 관리자

1.1.3. XFS는 기본 파일 시스템입니다.

1.1.4. 파일 시스템 재구성

/bin,/sbin,/lib, /lib64 디렉토리가 이제 /usr 아래에 중첩됩니다.

1.1.5. snapper

1.1.6. 1.8.0 (기술 프리뷰)

1.1.7. NFSv2 더 이상 지원되지 않음

I 부. 파일 시스템

2장. 파일 시스템 구조 및 유지 관리

- 편집할 수 있고 이해할 수 없는 파일

- 공유할 수 있는 파일은 로컬 및 원격 호스트에서 액세스할 수 있습니다. Unsharable 파일은 로컬에만 사용할 수 있습니다.

- 변수 및 정적 파일

- 문서와 같은 변수 파일은 언제든지 변경할 수 있습니다. 바이너리와 같은 정적 파일은 시스템 관리자의 작업 없이 변경되지 않습니다.

2.1. 파일 시스템 계층 구조 표준(FHS) 개요

- 다른 FHS 호환 시스템과의 호환성

/usr/파티션을 읽기 전용으로 마운트하는 기능. 이는/usr/에 공통 실행 파일이 포함되어 있으므로 사용자가 변경할 수 없기 때문에 중요합니다. 또한/usr/가 읽기 전용으로 마운트되므로 CD-ROM 드라이브 또는 읽기 전용 NFS 마운트를 통해 다른 시스템에서 마운트할 수 있어야 합니다.

2.1.1. FHS Organization

2.1.1.1. 파일 시스템 정보 수집

2.1.1.1.1. DF 명령

예 2.1. DF 명령 출력

Filesystem 1K-blocks Used Available Use% Mounted on

/dev/mapper/VolGroup00-LogVol00

11675568 6272120 4810348 57% / /dev/sda1

100691 9281 86211 10% /boot

none 322856 0 322856 0% /dev/shm

예 2.2. df -h Command Output

Filesystem Size Used Avail Use% Mounted on

/dev/mapper/VolGroup00-LogVol00

12G 6.0G 4.6G 57% / /dev/sda1

99M 9.1M 85M 10% /boot

none 316M 0 316M 0% /dev/shm

/dev/shm 은 시스템의 가상 메모리 파일 시스템을 나타냅니다.

2.1.1.1.2. du Command

2.1.1.1.3. GNOME 시스템 모니터

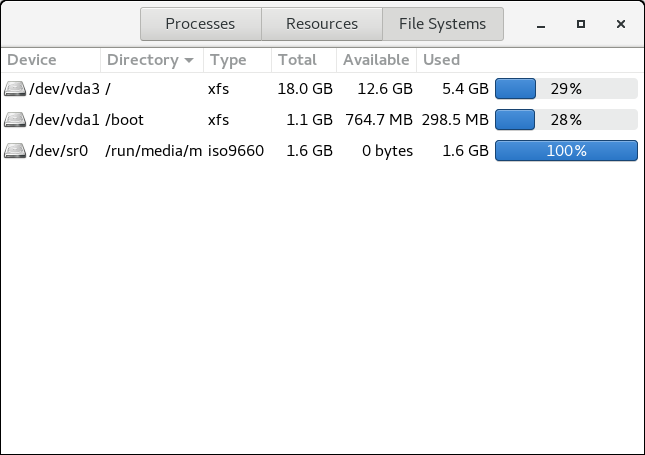

그림 2.1. GNOME 시스템 모니터의 파일 시스템 탭

[D]

2.1.1.2. /boot/ 디렉토리

/boot/ 디렉터리에는 시스템을 부팅하는 데 필요한 정적 파일(예: Linux 커널)이 포함되어 있습니다. 이러한 파일은 시스템이 올바르게 부팅되는 데 필수적입니다.

/boot/ 디렉토리를 제거하지 마십시오. 이렇게 하면 시스템을 부팅할 수 없게 됩니다.

2.1.1.3. /dev/ Directory

/dev/ 디렉터리에는 다음 장치 유형을 나타내는 장치 노드가 포함되어 있습니다.

- 시스템에 연결된 장치;

- 커널에서 제공하는 가상 장치.

/dev/ 에서 장치 노드를 생성하고 제거합니다.

/dev/ 디렉토리 및 하위 디렉토리에 있는 장치는 문자 (입력 및 출력의 직렬 스트림만 제공) 또는 블록 (예: 하드 드라이브 또는 플로피 드라이브와 같은 무작위로 액세스할 수 있음)으로 정의됩니다. GNOME 또는 KDE가 설치되면 일부 스토리지 장치가 자동으로 감지되거나 (예: USB) 또는 삽입(예: CD 또는 DVD 드라이브)이 표시되고 콘텐츠를 표시하는 팝업 창이 표시됩니다.

표 2.1. /dev 디렉터리에 있는 공통 파일의 예

| 파일 | 설명 |

|---|---|

/dev/hda | 기본 IDE 채널의 마스터 장치입니다. |

/dev/hdb | 기본 IDE 채널의 슬레이브 장치입니다. |

/dev/tty0 | 첫 번째 가상 콘솔. |

/dev/tty1 | 두 번째 가상 콘솔. |

/dev/sda | 기본 SCSI 또는 SATA 채널의 첫 번째 장치입니다. |

/dev/lp0 | 첫 번째 병렬 포트. |

- 매핑된 장치

- 볼륨 그룹의 논리 볼륨(예:

/dev/mapper/VolGroup00-LogVol02). - 고정 장치

- 기존 스토리지 볼륨(예: /dev/ sdb X )은 스토리지 장치 이름이며 X 는 파티션 번호입니다.

/dev/sdbX는/dev/disk/by-id/WWID또는/dev/disk/by-uuid/UUID일 수도 있습니다. 자세한 내용은 25.8절. “영구 이름 지정” 에서 참조하십시오.

2.1.1.4. /etc/ 디렉터리

/etc/ 디렉토리는 시스템에 로컬인 구성 파일에 대해 예약되어 있습니다. 바이너리가 포함되어 있지 않아야 합니다. 바이너리가 있는 경우 /usr/bin/ 또는 /usr/sbin/ 로 이동합니다.

/etc/skel/ 디렉터리는 사용자를 처음 생성할 때 홈 디렉터리를 채우는 데 사용되는 "스케일론" 사용자 파일을 저장합니다. 애플리케이션은 또한 구성 파일을 이 디렉터리에 저장하고 실행할 때 참조할 수 있습니다. /etc/exports 파일은 원격 호스트로 내보내는 파일 시스템을 제어합니다.

2.1.1.5. /mnt/ 디렉터리

/mnt/ 디렉터리는 NFS 파일 시스템 마운트와 같이 임시 마운트된 파일 시스템을 위해 예약되어 있습니다. 이동식 모든 스토리지 미디어에 대해 /media/ 디렉터리를 사용합니다. 감지된 이동식 미디어가 /media 디렉터리에 자동으로 마운트됩니다.

/mnt 디렉토리는 설치 프로그램에서 사용해서는 안 됩니다.

2.1.1.6. /opt/ Directory

/opt/ 디렉토리는 일반적으로 기본 설치의 일부가 아닌 소프트웨어 및 애드온 패키지용으로 예약되어 있습니다. /opt/ 에 설치하는 패키지는 해당 이름이 포함된 디렉토리를 만듭니다(예: /opt/packagename/ ). 대부분의 경우 이러한 패키지는 예측 가능한 하위 디렉토리 구조를 따릅니다. 대부분의 경우 바이너리를 /opt/packagename/bin/ 에 저장하고 해당 도움말 페이지를 /opt/패키지 이름/ man / 에 저장합니다.

2.1.1.7. /proc/ 디렉토리

/proc/ 디렉토리에는 커널에서 정보를 추출하거나 정보를 전송하는 특수 파일이 포함되어 있습니다. 이러한 정보의 예로는 시스템 메모리, CPU 정보 및 하드웨어 구성이 있습니다. /proc/ 에 대한 자세한 내용은 2.3절. “/proc 가상 파일 시스템” 을 참조하십시오.

2.1.1.8. /srv/ 디렉터리

/srv/ 디렉터리에는 Red Hat Enterprise Linux 시스템에서 제공하는 사이트별 데이터가 포함되어 있습니다. 이 디렉토리는 사용자에게 FTP, WWW 또는 CVS와 같은 특정 서비스에 대한 데이터 파일의 위치를 제공합니다. 특정 사용자와 관련된 데이터만 /home/ 디렉토리에 있어야 합니다.

2.1.1.9. /sys/ 디렉터리

/sys/ 디렉터리는 커널과 관련된 새로운 sysfs 가상 파일 시스템을 사용합니다. 커널의 핫 플러그 하드웨어 장치에 대한 지원이 늘어남에 따라 /sys/ 디렉터리에는 /proc/ 에서 유지하는 것과 유사한 정보가 포함되어 있지만 핫 플러그 장치와 관련된 장치 정보의 계층적 보기가 표시됩니다.

2.1.1.10. /usr/ Directory

/usr/ 디렉토리는 여러 시스템에서 공유할 수 있는 파일용입니다. /usr/ 디렉토리는 종종 자체 파티션에 있으며 읽기 전용으로 마운트됩니다. 최소한 /usr/ 에는 다음 하위 디렉터리가 포함되어야 합니다.

/usr/bin- 이 디렉터리는 바이너리에 사용됩니다.

/usr/etc- 이 디렉터리는 시스템 전체 구성 파일에 사용됩니다.

/usr/ games- 이 디렉토리는 게임을 저장합니다.

/usr/include- 이 디렉토리는 C 헤더 파일에 사용됩니다.

/usr/kerberos- 이 디렉터리는 Kerberos 관련 바이너리 및 파일에 사용됩니다.

/usr/lib- 이 디렉토리는 쉘 스크립트 또는 사용자가 직접 사용하도록 설계되지 않은 오브젝트 파일 및 라이브러리에 사용됩니다.Red Hat Enterprise Linux 7.0부터

/lib/디렉터리가/usr/lib과 병합되었습니다. 이제/usr/bin/및/usr/sbin/에서 바이너리를 실행하는 데 필요한 라이브러리도 포함됩니다. 이러한 공유 라이브러리 이미지는 시스템을 부팅하거나 루트 파일 시스템 내에서 명령을 실행하는 데 사용됩니다. /usr/libexec- 이 디렉토리에는 다른 프로그램에서 호출되는 작은 도우미 프로그램이 포함되어 있습니다.

/usr/sbin- Red Hat Enterprise Linux 7.0부터

/sbin이/usr/sbin으로 변경되었습니다. 즉, 시스템 부팅, 복원, 복구 또는 복구에 필요한 시스템 관리 바이너리를 포함하여 모든 시스템 관리 바이너리가 포함됩니다./usr/sbin/의 바이너리에는 사용할 수 있는 root 권한이 필요합니다. /usr/share- 이 디렉터리는 아키텍처별로 차별화되지 않은 파일을 저장합니다.

/usr/src- 이 디렉터리는 소스 코드를 저장합니다.

/usr/tmp가/var/tmp에 연결됩니다.- 이 디렉터리는 임시 파일을 저장합니다.

/usr/ 디렉토리에는 /local/ 하위 디렉터리도 포함되어야 합니다. FHS에 따라 이 하위 디렉터리는 시스템 관리자가 로컬로 소프트웨어를 설치할 때 사용되며 시스템 업데이트 중에 안전하게 덮어쓰지 않아야 합니다. /usr/ local 디렉터리에는 /usr/ 과 유사한 구조가 있으며 다음 하위 디렉터리를 포함합니다.

/usr/local/bin/usr/local/etc/usr/local/plays/usr/local/include/usr/local/lib/usr/local/libexec/usr/local/sbin/usr/local/share/usr/local/src

/usr/local/ 사용은 FHS와 약간 다릅니다. FHS는 시스템 소프트웨어 업그레이드로부터 안전해야 하는 소프트웨어를 저장하는 데 /usr/local/ 를 사용해야 한다고 명시되어 있습니다. RPM 패키지 관리자는 소프트웨어 업그레이드를 안전하게 수행할 수 있으므로 /usr/local/ 에 파일을 저장하여 파일을 보호할 필요가 없습니다.

/usr/local/ 를 사용합니다. 예를 들어 /usr/ 디렉토리가 원격 호스트의 읽기 전용 NFS 공유로 마운트된 경우에도 /usr/local/ 디렉터리에 패키지 또는 프로그램을 설치할 수 있습니다.

2.1.1.11. /var/ 디렉터리

/usr/ 를 읽기 전용으로 마운트해야 하므로 로그 파일을 쓰거나 spool/ 또는 lock/ 디렉터리가 필요한 모든 프로그램을 /var/ 디렉토리에 써야 합니다. FHS는 /var/ 가 변수 데이터로, 스풀 디렉토리 및 파일, 로깅 데이터, 임시 파일을 포함합니다.

/var/ 디렉터리에 있는 일부 디렉터리입니다.

/var/account//var/arpwatch//var/cache//var/crash//var/db//var/empty//var/ftp//var/gdm//var/kerberos//var/lib//var/local//var/lock//var/log//var/spool/mail/에 연결된/var/mail/var/mailman//var/named//var/nis//var/opt//var/preserve//var/run//var/spool//var/tmp//var/tux//var/www//var/yp/

/var/run/media/사용자 디렉터리에는 USB 스토리지 미디어, DVD, CD-ROM, Zip 디스크와 같은 이동식 미디어의 마운트 지점으로 사용되는 하위 디렉터리가 포함되어 있습니다. 이전에는 /media/ 디렉터리가 이 용도로 사용되었습니다.

메시지 및 lastlog 와 같은 시스템 로그 파일은 /var/log/ 디렉토리에 있습니다. /var/lib/rpm/ 디렉터리에는 RPM 시스템 데이터베이스가 포함되어 있습니다. 잠금은 /var/lock/ 디렉토리에 파일을 사용하는 프로그램의 디렉토리에 있습니다. /var/spool/ 디렉터리에는 일부 프로그램의 데이터 파일을 저장하는 하위 디렉터리가 있습니다. 이러한 하위 디렉터리에는 다음이 포함됩니다.

/var/spool/at//var/spool/clientmqueue//var/spool/cron//var/spool/cups//var/spool/exim//var/spool/lpd//var/spool/mail//var/spool/mailman//var/spool/mqueue//var/spool/news//var/spool/postfix//var/spool/repackage//var/spool/rwho//var/spool/samba//var/spool/squid//var/spool/squirrelmail//var/spool/up2date//var/spool/uucp//var/spool/uucppublic//var/spool/vbox/

2.2. 특수 Red Hat Enterprise Linux 파일 위치

/var/lib/rpm/ 디렉토리에 보관됩니다. RPM에 대한 자세한 내용은 man rpm 을 참조하십시오.

/var/cache/yum/ 디렉터리에는 시스템의 RPM 헤더 정보를 포함하여 패키지 업데이트 관리자에서 사용하는 파일이 포함되어 있습니다. 이 위치는 시스템을 업데이트하는 동안 다운로드한 RPM을 임시로 저장하는 데도 사용할 수 있습니다. Red Hat Network에 대한 자세한 내용은 https://rhn.redhat.com/ 을 참조하십시오.

/etc/sysconfig/ 디렉터리입니다. 이 디렉터리는 다양한 구성 정보를 저장합니다. 부팅 시 실행되는 많은 스크립트는 이 디렉터리의 파일을 사용합니다.

2.3. /proc 가상 파일 시스템

/proc 에는 텍스트 또는 바이너리 파일이 포함되어 있지 않습니다. 가상 파일이 포함되어 있기 때문에 /proc 는 가상 파일 시스템이라고 합니다. 이러한 가상 파일은 많은 양의 정보가 포함되어 있어도 일반적으로 크기가 0바이트입니다.

/proc 파일 시스템은 스토리지에 사용되지 않습니다. 주요 목적은 하드웨어, 메모리, 실행 중인 프로세스 및 기타 시스템 구성 요소에 파일 기반 인터페이스를 제공하는 것입니다. 해당 /proc 파일을 확인하여 많은 시스템 구성 요소에서 실시간 정보를 검색할 수 있습니다. /proc 내의 일부 파일은 (사용자 및 애플리케이션 모두) 커널을 구성하기 위해 조작할 수도 있습니다.

/proc 파일은 시스템 스토리지를 관리하고 모니터링하는 것과 관련이 있습니다.

- /proc/devices

- 현재 구성된 다양한 문자 및 블록 장치를 표시합니다.

- /proc/filesystems

- 커널은 현재 지원하는 모든 파일 시스템 유형을 나열합니다.

- /proc/mdstat

- 시스템의 여러 디스크 또는 RAID 구성(있는 경우)에 대한 현재 정보를 포함합니다.

- /proc/mounts

- 시스템에서 현재 사용하는 모든 마운트를 나열합니다.

- /proc/partitions

- 파티션 블록 할당 정보가 포함되어 있습니다.

/proc 파일 시스템에 대한 자세한 내용은 Red Hat Enterprise Linux 7 배포 가이드를 참조하십시오.

2.4. 사용되지 않는 블록 삭제

- 일괄 삭제 작업은 fstrim 명령을 사용하여 사용자가 명시적으로 실행합니다. 이 명령은 사용자 기준과 일치하는 파일 시스템에서 사용되지 않은 모든 블록을 삭제합니다.

- 온라인 삭제 작업은 마운트 명령의 일부로

-o discard옵션을 사용하거나/etc/fstab파일의discard옵션을 사용하여 마운트 시 지정됩니다. 사용자 개입 없이 실시간으로 실행됩니다. 온라인 삭제 작업에서는 사용 가능한 블록만 삭제합니다.

/sys/block/device/queue/discard_max_bytes 파일에 저장된 값이 0이 아닌 경우 물리적 삭제 작업이 지원됩니다.

- 삭제 작업을 지원하지 않는 장치 또는

- 장치 중 하나가 삭제 작업을 지원하지 않는 여러 장치로 구성된 논리 장치(LVM 또는 MD)

fstrim -v /mnt/non_discard

fstrim: /mnt/non_discard: the discard operation is not supported

3장. XFS 파일 시스템

- XFS의 주요 기능

- XFS는 더 빠른 충돌 복구를 용이하게 하는 메타데이터 저널링 을 지원합니다.

- XFS 파일 시스템은 마운트된 활성 상태에서 조각 모음 및 확대될 수 있습니다.

- 또한 Red Hat Enterprise Linux 7은 XFS와 관련된 백업 및 복원 유틸리티를 지원합니다.

- 할당 기능

- XFS에는 다음과 같은 할당 체계가 있습니다.

- 범위 기반 할당

- 스트라이프 인식 할당 정책

- 할당량 지연

- 공간 사전 할당

지연된 할당 및 기타 성능 최적화는 XFS에 ext4와 동일한 방식으로 영향을 미칩니다. 즉, 프로그램이 나중에 fsync() 호출을 발행하지 않는 한, XFS 파일 시스템에 대한 프로그램의 쓰기는 디스크상의 것이 보장되지 않습니다.파일 시스템에서 지연된 할당의 영향에 대한 자세한 내용은 할당 기능 의 5장. ext4 파일 시스템 를 참조하십시오.참고디스크 공간이 충분한 것처럼 보이는 경우에도 예기치 않은 ENOSPC 쓰기 실패와 함께 파일을 만들거나 확장하는 데 실패하는 경우가 있습니다. 이는 XFS의 성능 지향 설계 때문입니다. 실제로는 나머지 공간이 몇 블록일 경우에만 발생하기 때문에 문제가 되지 않습니다. - 기타 XFS 기능

- XFS 파일 시스템은 다음과 같은 기능도 지원합니다.

- 확장 속성 (

xattr) - 이를 통해 시스템은 파일마다 여러 개의 추가 이름/값 쌍을 연결할 수 있습니다. 기본적으로 활성화되어 있습니다.

- 할당량 저널링

- 이렇게 하면 충돌 후 긴 할당량 일관성 검사가 필요하지 않습니다.

- 프로젝트/디렉터리 할당량

- 이렇게 하면 디렉터리 트리에 대한 할당량 제한이 허용됩니다.

- 서브초 타임스탬프

- 이렇게 하면 타임 스탬프가 하위초로 이동할 수 있습니다.

- 확장 속성 (

- 기본 atime 동작은 relatime입니다.

- relatime 은 기본적으로 XFS에 대해 입니다. sane atime 값을 유지하면서 noatime 에 비해 오버헤드가 거의 없습니다.

3.1. XFS 파일 시스템 생성

- XFS 파일 시스템을 생성하려면 다음 명령을 사용합니다.

#mkfs.xfs block_device- block_device 를 블록 장치의 경로로 교체합니다. 예를 들어

/dev/sdb1,/dev/disk/by-uuid/05e99ec8-def1-4a5e-8a9d-59453ceb2a,/dev/my-volgroup/my-lv. - 일반적으로 기본 옵션은 일반적인 용도로 최적입니다.

- 기존 파일 시스템이 포함된 블록 장치에서 mkfs.xfs 를 사용하는 경우

-f옵션을 추가하여 해당 파일 시스템을 덮어씁니다.

예 3.1. mkfs.xfs 명령 출력

meta-data=/dev/device isize=256 agcount=4, agsize=3277258 blks

= sectsz=512 attr=2

data = bsize=4096 blocks=13109032, imaxpct=25

= sunit=0 swidth=0 blks

naming =version 2 bsize=4096 ascii-ci=0

log =internal log bsize=4096 blocks=6400, version=2

= sectsz=512 sunit=0 blks, lazy-count=1

realtime =none extsz=4096 blocks=0, rtextents=0

사용되지 않는 블록 장치

mkfs 유틸리티( ext3, ext4 및 xfs의 경우)는 이 지오메트리를 자동으로 사용합니다. 스트라이프 지오메트리는 mkfs 유틸리티에 의해 감지되지 않으며 실제로 스토리지에서 스트라이프 지오메트리가 있더라도 다음 옵션을 사용하여 파일 시스템을 만들 때 수동으로 지정할 수 있습니다.

- su=value

- 스트라이프 단위 또는 RAID 청크 크기를 지정합니다. 값은

k,m또는g접미사를 사용하여 바이트 단위로 지정해야 합니다. - sw=value

- RAID 장치의 데이터 디스크 수 또는 스트라이프의 스트라이프 단위 수를 지정합니다.

# mkfs.xfs -d su=64k,sw=4 /dev/block_device추가 리소스

- mkfs.xfs(8) 도움말 페이지

3.2. XFS 파일 시스템 마운트

# mount /dev/device /mount/pointmke2fs 와 달리mkfs.xfs 는 구성 파일을 사용하지 않으며 모두 명령줄에 지정됩니다.

3.2.1. 쓰기 Barriers

# mount -o nobarrier /dev/device /mount/point3.2.2. 직접 액세스 기술 프리뷰

Direct Access (DAX)는 ext4 및 XFS 파일 시스템에서 기술 프리뷰로 사용할 수 있습니다. 이는 애플리케이션이 영구 메모리를 주소 공간에 직접 매핑하는 수단입니다. DAX를 사용하려면 시스템에서 일부 형태의 영구 메모리를 사용할 수 있어야 합니다. 일반적으로 비 VDIMM(Non-Volatile Dual Inline Memory Modules)과 DAX를 지원하는 파일 시스템을 NVDIMM(s)에서 생성해야 합니다. 또한 dax 마운트 옵션을 사용하여 파일 시스템을 마운트해야 합니다. 그런 다음 dax-mounted 파일 시스템에 있는 파일의 mmap 을 애플리케이션 주소 공간에 직접 매핑합니다.

3.3. XFS 할당량 관리

- uquota/uqnoenforce: 사용자 할당량

- gquota/gqnoenforce: 그룹 할당량

- pquota/pqnoenforce: 프로젝트 할당량

- quota username/userID

- 지정된 사용자 이름 또는 숫자 userID의 사용량 및 제한 표시

- df

- 블록 및 inode에 대해 무료이고 사용되는 수를 표시합니다.

# xfs_quota -x- 보고서 /path

- 특정 파일 시스템에 대한 할당량 정보를 보고합니다.

- limit

- 할당량 제한을 수정합니다.

예 3.2. 샘플 할당량 보고서 표시

/home ( /dev/blockdevice에서)에 대한 샘플 할당량 보고서를 표시하려면 xfs_quota -x -c 'report -h' /home 명령을 사용합니다. 그러면 다음과 유사한 출력이 표시됩니다.

User quota on /home (/dev/blockdevice) Blocks User ID Used Soft Hard Warn/Grace ---------- --------------------------------- root 0 0 0 00 [------] testuser 103.4G 0 0 00 [------] ...

/home/john 인 사용자 john 에 대해 소프트 및 하드 inode 수 제한을 각각 설정하려면 다음 명령을 사용합니다.

# xfs_quota -x -c 'limit isoft=500 ihard=700 john' /home/예 3.3. 소프트 및 하드 블록 제한 설정

/target/path 파일 시스템에서 accounting 그룹으로 설정하려면 다음 명령을 사용합니다.

# xfs_quota -x -c 'limit -g bsoft=1000m bhard=1200m accounting' /target/path3.3.1. 프로젝트 제한 설정

- 프로젝트 제어 디렉토리를

/etc/projects에 추가합니다. 예를 들어 다음은 고유 ID가 11인/var/log경로를/etc/projects에 추가합니다. 프로젝트 ID는 프로젝트에 매핑된 모든 숫자 값일 수 있습니다.#echo 11:/var/log >> /etc/projects /etc/projid에 프로젝트 이름을 추가하여 프로젝트 ID를 프로젝트 이름에 매핑합니다. 예를 들어 다음에서는 Logs라는 프로젝트를 이전 단계에서 정의한 대로 프로젝트 ID 11과 연결합니다.#echo Logs:11 >> /etc/projid- 프로젝트 디렉터리를 초기화합니다. 예를 들어 다음은 프로젝트 디렉토리

/var:를 초기화합니다.#xfs_quota -x -c 'project -s logfiles' /var - 초기화된 디렉터리를 사용하여 프로젝트의 할당량을 구성합니다.

#xfs_quota -x -c 'limit -p bhard=lg logfiles' /var

3.4. XFS 파일 시스템의 크기 늘리기

# xfs_growfs /mount/point -D size3.5. XFS 파일 시스템 복구

# xfs_repair /dev/device3.6. XFS 파일 시스템 일시 중단

# xfs_freeze mount-pointxfsprogs 패키지에서 제공하며 x86_64에서만 사용할 수 있습니다.

# xfs_freeze -f /mount/point

# xfs_freeze -u /mount/point3.7. XFS 파일 시스템 백업 및 복원

- 백업 생성을 위한 xfsdump

- 백업에서 복원하는 xfsrestore

3.7.1. XFS 백업 및 복원 기능

3.7.1.1. Backup

xfsdump 유틸리티를 사용하여 다음을 수행할 수 있습니다.

- 일반 파일 이미지에 대한 백업을 수행합니다.일반 파일에 하나의 백업만 쓸 수 있습니다.

- 테이프 드라이브에 백업을 수행합니다.

xfsdump유틸리티를 사용하면 동일한 테이프에 여러 백업을 쓸 수도 있습니다. 백업은 여러 개의 테이프에 걸쳐 있을 수 있습니다.여러 파일 시스템을 단일 테이프 장치에 백업하려면 이미 XFS 백업이 포함된 테이프에 백업을 작성합니다. 그러면 이전 백업에 새 백업이 추가됩니다. 기본적으로xfsdump는 기존 백업을 덮어쓰지 않습니다. - 증분 백업을 생성합니다.

xfsdump유틸리티는 덤프 수준을 사용하여 다른 백업이 상대적인 기본 백업을 결정합니다.0에서9까지의 숫자는 덤프 수준 증가를 나타냅니다. 증분 백업은 낮은 수준의 마지막 덤프 이후 변경된 파일만 백업합니다.- 전체 백업을 수행하려면 파일 시스템에서 수준 0 덤프를 수행합니다.

- 수준 1 덤프는 전체 백업 후 첫 번째 증분 백업입니다. 다음 증분 백업은 레벨 2로, 마지막 레벨 1 덤프 이후 변경된 파일만 최대 레벨 9로 백업합니다.

- size, subtree 또는 inode 플래그를 사용하여 백업에서 파일을 제외하여 필터링합니다.

3.7.1.2. 복원

xfsrestore 대화형 모드를 입력합니다. 대화형 모드는 백업 파일을 조작하는 명령 집합을 제공합니다.

3.7.2. XFS 파일 시스템 백업

절차 3.1. XFS 파일 시스템 백업

- 다음 명령을 사용하여 XFS 파일 시스템을 백업합니다.

#xfsdump -l level [-L label] -f backup-destination path-to-xfs-filesystem- level 을 백업의 덤프 수준으로 바꿉니다.

0을 사용하여 누적 증분 백업을 수행하려면 전체 백업 또는1~9 - backup-destination 을 백업을 저장할 경로로 교체합니다. 대상은 일반 파일, 테이프 드라이브 또는 원격 테이프 장치일 수 있습니다. 예를 들어, 파일

/backup-files/Data.xfsdump또는 테이프 드라이브의 경우/dev/st0입니다. - path-to-xfs-filesystem 을 백업하려는 XFS 파일 시스템의 마운트 지점으로 바꿉니다. 예를 들면

/mnt/data/입니다. 파일 시스템이 마운트되어야 합니다. - 여러 파일 시스템을 백업하고 단일 테이프 장치에 저장할 때

-L 라벨 옵션을 사용하여 각 백업에 세션 레이블을 추가하여 복원할 때 보다 쉽게 식별할 수 있습니다. 레이블을 백업의 이름으로 바꿉니다(예:backup_data).

예 3.4. 여러 XFS 파일 시스템 백업

/boot/및/data/디렉토리에 마운트된 XFS 파일 시스템의 내용을 백업하고/backup-files/디렉토리에 파일로 저장합니다.#xfsdump -l 0 -f /backup-files/boot.xfsdump /boot#xfsdump -l 0 -f /backup-files/data.xfsdump /data- 단일 테이프 장치에서 여러 파일 시스템을 백업하려면

-L 라벨 옵션을 사용하여 각 백업에 세션 레이블을추가합니다.#xfsdump -l 0 -L "backup_boot" -f /dev/st0 /boot#xfsdump -l 0 -L "backup_data" -f /dev/st0 /data

추가 리소스

- XFS 파일 시스템 백업에 대한 자세한 내용은 xfsdump(8) 도움말 페이지를 참조하십시오.

3.7.3. 백업에서 XFS 파일 시스템 복원

사전 요구 사항

- 3.7.2절. “XFS 파일 시스템 백업” 에 설명된 대로 XFS 파일 시스템의 파일 또는 테이프 백업이 필요합니다.

절차 3.2. 백업에서 XFS 파일 시스템 복원

- 백업 복원 명령은 전체 백업 또는 증분 백업에서 복원하는지에 따라 달라집니다.The command to restore the backup vary depending on whether you are restoring from a full backup or an incremental one, or are restoring multiple backups from a single tape device:

#xfsrestore [-r] [-S session-id] [-L session-label] [-i]-f backup-locationrestoration-path- 백업 위치를 백업 위치로 교체합니다. 이는 일반 파일, 테이프 드라이브 또는 원격 테이프 장치일 수 있습니다.This can be a regular file, a tape drive, or a remote tape device. 예를 들어, 파일

/backup-files/Data.xfsdump또는 테이프 드라이브의 경우/dev/st0입니다. - restoration-path 를 파일 시스템을 복원할 디렉터리의 경로로 바꿉니다. 예를 들면

/mnt/data/입니다. - 증분(레벨 1에서 레벨 9) 백업에서 파일 시스템을 복원하려면

-r옵션을 추가합니다. - 여러 백업이 포함된 테이프 장치에서 백업을 복원하려면

-S또는-L옵션을 사용하여 백업을 지정합니다.S를 사용하면 세션 ID로 백업을 선택할 수 있지만-L을 사용하면 세션 라벨에 따라 선택할 수 있습니다. 세션 ID 및 세션 레이블을 가져오려면 xfsrestore -I 명령을 사용합니다.session-id 를 백업의 세션 ID로 교체합니다. 예를 들어b74a3586-e52e-4a4a-8775-c3334fa8ea2c. session-label 을 백업의 세션 레이블로 바꿉니다. 예를 들면my_backup_session_label입니다. - 대화형으로

xfsrestore를 사용하려면-i옵션을 사용합니다.대화형 대화 상자는xfsrestore가 지정된 장치를 읽은 후에 시작됩니다. 대화형xfsrestore쉘에서 사용 가능한 명령에는 cd,ls,add,delete, extract; 명령 전체 목록은 help 명령을 사용합니다.

예 3.5. 여러 XFS 파일 시스템 복원

/mnt/ 아래의 디렉터리에 저장하려면 다음을 수행합니다.

#xfsrestore -f /backup-files/boot.xfsdump /mnt/boot/#xfsrestore -f /backup-files/data.xfsdump /mnt/data/

#xfsrestore -f /dev/st0 -L "backup_boot" /mnt/boot/#xfsrestore -f /dev/st0 -S "45e9af35-efd2-4244-87bc-4762e476cbab" /mnt/data/

Tape에서 백업을 복원 할 때 정보 메시지

xfsrestore 유틸리티에서 메시지를 발행할 수 있습니다. 이 메시지는 xfsrestore 가 순서대로 테이프에서 각 백업을 검사할 때 요청된 백업이 있는지 여부를 알려줍니다. 예를 들어 다음과 같습니다.

xfsrestore: preparing drive xfsrestore: examining media file 0 xfsrestore: inventory session uuid (8590224e-3c93-469c-a311-fc8f23029b2a) does not match the media header's session uuid (7eda9f86-f1e9-4dfd-b1d4-c50467912408) xfsrestore: examining media file 1 xfsrestore: inventory session uuid (8590224e-3c93-469c-a311-fc8f23029b2a) does not match the media header's session uuid (7eda9f86-f1e9-4dfd-b1d4-c50467912408) [...]

추가 리소스

- XFS 파일 시스템을 복원하는 방법에 대한 자세한 내용은 xfsrestore(8) 도움말 페이지를 참조하십시오.

3.8. 오류 동작 구성

- 다음 중 하나로 다시 시도합니다.

- I/O 작업이 성공 또는

- I/O 작업 재시도 횟수 또는 제한 시간이 초과되었습니다.

- 오류가 영구적으로 고려되고 시스템을 중단합니다.

EIO: 장치에 쓰기를 시도하는 동안 오류가 발생했습니다.ENOSPC: 장치에 남아 있는 공간이 없습니다.ENODEV: 장치를 찾을 수 없습니다.

3.8.1. 특정 조건 및 정의되지 않은 조건에 대한 구성 파일

/sys/fs/xfs/device/error/ 디렉토리에 있습니다.

/sys/fs/xfs/장치/error/metadata/ 디렉터리에는 각 특정 오류 조건에 대한 하위 디렉터리가 포함되어 있습니다.

EIO 오류 조건의 경우 /sys/fs/xfs/장치/error/metadata/EIO/ENODEV 오류 조건의 경우 /sys/fs/xfs/장치/error/metadata/ENODEV/ENOSPC 오류 조건의 경우 /sys/fs/xfs/장치/error/metadata/ENOSPC/

/sys/fs/xfs/장치/error/metadata/조건/max_retries: XFS가 작업을 다시 시도하는 최대 횟수를 제어합니다./sys/fs/xfs/장치/error/metadata/condition/retry_timeout_seconds: XFS가 작업 재시도를 중지하는 시간 제한(초)

/sys/fs/xfs/장치/error/metadata/default/max_retries: 최대 재시도 횟수를 제어합니다./sys/fs/xfs/장치/error/metadata/default/retry_timeout_seconds: 재시도 시간 제한을 제어합니다.

3.8.2. 특정 및 정의되지 않은 조건에 대해 파일 시스템 동작 설정

max_retries 파일에 씁니다.

- 특정 조건의 경우:

#echo value > /sys/fs/xfs/device/error/metadata/condition/max_retries - 정의되지 않은 조건의 경우:

#echo value > /sys/fs/xfs/device/error/metadata/default/max_retries

-1 과 가능한 최대 값 int, C 부호 있는 정수 유형 사이의 숫자입니다. 64비트 Linux에서 2147483647 입니다.

retry_timeout_seconds 파일에 씁니다.

- 특정 조건의 경우:

#echo value > /sys/fs/xfs/device/error/metadata/condition/retry_timeout_seconds - 정의되지 않은 조건의 경우:

#echo value > /sys/fs/xfs/device/error/metadata/default/retry_timeout_seconds

-1 과 86400 사이의 숫자이며 하루 중 초 수입니다.

max_retries 및 retry_timeout_seconds 옵션 모두에서 -1 은 영원히 재시도 하여 즉시 중지합니다.

/dev/ 디렉토리에 있는 것처럼 장치 이름입니다(예: sda ).

ENODEV 와 같은 일부 오류는 재시도 횟수에 관계없이 치명적 및 복구 가능으로 간주되므로 기본값은 0 입니다.

3.8.3. 마운트 해제 동작 설정

fail_at_unmount 옵션이 설정되면 파일 시스템은 마운트 해제 중에 다른 모든 오류 구성을 재정의하고 I/O 작업을 다시 시도하지 않고 즉시 파일 시스템을 제거합니다. 이를 통해 영구 오류 발생 경우에도 마운트 해제 작업이 성공할 수 있습니다.

# echo value > /sys/fs/xfs/device/error/fail_at_unmount1 또는 0 입니다.

1오류가 발견되면 즉시 재시도를 취소하는 것을 의미합니다.0은max_retries및retry_timeout_seconds옵션을 존중하는 것을 의미합니다.

/dev/ 디렉토리에 있는 것처럼 장치 이름입니다(예: sda ).

fail_at_unmount 옵션을 원하는 대로 설정해야 합니다. 마운트 해제 작업이 시작되면 구성 파일 및 디렉터리를 사용할 수 없습니다.

3.9. 기타 XFS 파일 시스템 유틸리티

- xfs_fsr

- 마운트된 XFS 파일 시스템을 조각 모음하는 데 사용됩니다. 인수 없이 호출할 때 xfs_fsr 는 마운트된 모든 XFS 파일 시스템의 모든 일반 파일을 조각 모음합니다. 이 유틸리티를 사용하면 사용자가 지정된 시간에 조각 모음을 중단하고 나중에 중단한 위치에서 다시 시작할 수 있습니다.또한 xfs_fsr 는 xfs_fsr /path/to/file 과 같이 하나의 파일의 조각 모음만 허용합니다. Red Hat은 XFS가 기본적으로 조각화를 방지하기 때문에 전체 파일 시스템을 주기적으로 축소하지 않도록 권장합니다. 시스템의 다양한 조각 모음으로 인해 여유 공간에서 조각화의 부작용을 초래할 수 있습니다.

- xfs_bmap

- XFS 파일 시스템의 파일에서 사용하는 디스크 블록 맵을 출력합니다. 이 맵은 지정된 파일에서 사용하는 각 범위와 해당 블록(즉, 홀더)이 없는 파일의 영역을 나열합니다.

- xfs_info

- XFS 파일 시스템 정보를 출력합니다.

- xfs_admin

- XFS 파일 시스템의 매개변수를 변경합니다. xfs_admin 유틸리티는 마운트 해제된 장치 또는 파일 시스템의 매개변수만 수정할 수 있습니다.

- xfs_copy

- 전체 XFS 파일 시스템의 콘텐츠를 병렬로 하나 이상의 대상에 복사합니다.

- xfs_metadump

- XFS 파일 시스템 메타데이터를 파일에 복사합니다. Red Hat은 마운트 해제된 파일 시스템 또는 읽기 전용 파일 시스템을 복사하는 데 xfs_metadump 유틸리티만 지원합니다. 그러지 않으면 생성되는 덤프가 손상되거나 일치하지 않을 수 있습니다.

- xfs_mdrestore

- XFS metadump 이미지( xfs_metadump를 사용하여 생성)를 파일 시스템 이미지로 복원합니다.

- xfs_db

- XFS 파일 시스템을 디버깅합니다.

3.10. ext4에서 XFS로 마이그레이션

3.10.1. Ext3/4 및 XFS 간 차이점

- 파일 시스템 복구

- Ext3/4는 필요에 따라 저널을 복구하기 위해 부팅 시 사용자 공간에서 e2fsck 를 실행합니다. XFS는 마운트 시 커널 공간에서 저널 복구를 수행합니다.

fsck.xfs쉘 스크립트는 제공되지만 initscript 요구 사항을 충족하기 위해서만 있으므로 유용한 작업을 수행하지 않습니다.XFS 파일 시스템을 복구하거나 확인할 때 xfs_repair 명령을 사용합니다. 읽기 전용 검사에는 -n 옵션을 사용합니다.xfs_repair 명령은 더티 로그가 있는 파일 시스템에서 작동하지 않습니다. 이러한 파일 시스템을 복구하고 마운트 해제 하려면 먼저 로그를 재생해야합니다. 로그가 손상되어 재생할 수 없는 경우 로그에서 -L 옵션을 사용하여 로그아웃할 수 있습니다.파일 시스템 복구에 대한 자세한 내용은 XFS 파일 시스템을 참조하십시오. 12.2.2절. “XFS” - 메타데이터 오류 동작

- 메타데이터 오류가 발생할 때 ext3/4 파일 시스템의 구성 가능한 동작이 있어 기본 동작은 계속 수행됩니다. XFS가 복구할 수 없는 메타데이터 오류가 발생하면 파일 시스템을 종료하고

EFSCORRUPTED오류를 반환합니다. 시스템 로그에 발생한 오류에 대한 세부 정보가 포함되어 있으며 필요한 경우 xfs_repair 를 실행하는 것이 좋습니다. - 할당량

- XFS 할당량은 다시 마운트할 수 없는 옵션입니다. 할당량을 적용하려면 초기 마운트에 -o 할당량 옵션을 지정해야 합니다.할당량 패키지의 표준 툴은 기본 할당량 관리 작업(예: setquota 및 repquota)을 수행할 수 있지만 xfs_quota 툴은 프로젝트 할당량 관리와 같은 XFS별 기능에 사용할 수 있습니다.quotacheck 명령은 XFS 파일 시스템에 영향을 미치지 않습니다. 할당량 회계가 XFS를 처음 켜는 경우 내부적으로 자동 할당량 검사를 수행합니다. XFS 할당량 메타데이터는 최상위, 저널링 메타데이터 오브젝트이므로 할당량이 수동으로 해제될 때까지 할당량 시스템은 항상 일관되게 유지됩니다.

- 파일 시스템 크기 조정

- XFS 파일 시스템에는 파일 시스템을 축소하는 유틸리티가 없습니다. XFS 파일 시스템은 xfs_growfs 명령을 통해 온라인으로 확장할 수 있습니다.

- inode 번호

- 256바이트 inode가 있거나 512바이트 inode가 있는 2TB보다 큰 파일 시스템의 경우 XFS inode 번호는 2^32를 초과할 수 있습니다. 이러한 대규모 inode 번호로 인해 EOVERFLOW 반환 값과 함께 32비트 stat 호출이 실패합니다. 기본 Red Hat Enterprise Linux 7 구성을 사용할 때 설명된 문제가 발생할 수 있습니다: 4개의 할당 그룹으로 정리되지 않은 문제가 발생할 수 있습니다. 사용자 지정 구성(예: 파일 시스템 확장 또는 XFS 파일 시스템 매개변수 변경)은 다른 동작이 발생할 수 있습니다.애플리케이션은 일반적으로 이러한 대규모 inode 번호를 올바르게 처리합니다. 필요한 경우 -o inode32 매개변수로 XFS 파일 시스템을 마운트하여 2^32 미만의 inode 번호를 적용합니다.

inode32는 64비트 숫자로 이미 할당된 inode에는 영향을 미치지 않습니다.중요특정 환경에 필요하지 않은 경우inode32옵션을 사용하지 마십시오.inode32옵션은 할당 동작을 변경합니다. 결과적으로 하위 디스크 블록에서 inode를 할당할 수 있는 공간이 없는 경우 ENOSPC 오류가 발생할 수 있습니다. - 사양 사전 할당

- XFS는 사양 사전 할당 을 사용하여 파일이 작성된 대로 이전 EOF 블록을 할당합니다. 따라서 NFS 서버에서 동시 스트리밍 쓰기 워크로드로 인해 파일 조각화가 발생하지 않습니다. 기본적으로 이 사전 할당은 파일 크기와 함께 증가하며 "du" 출력에 표시됩니다. 사양 사전 할당이 있는 파일이 5분 동안 처리되지 않은 경우 사전 할당이 삭제됩니다. 해당 시간 이전에 inode가 캐시에서 순환되면 inode가 회수될 때 사전 할당이 삭제됩니다.투기 사전 할당으로 인해 premature ENOSPC 문제가 표시되는 경우 -o allocsize=amount 마운트 옵션으로 고정된 사전 할당 양을 지정할 수 있습니다.

- 조각화 관련 툴

- 조각화는 지연된 할당 및 예상 사전 할당과 같은 heuristics 및 동작으로 인해 XFS 파일 시스템에서 심각한 문제가 거의 없습니다. 그러나 파일 시스템 조각화 측정 및 파일 시스템 조각 모음을 위한 도구가 있습니다. 사용하는 것은 권장되지 않습니다.xfs_db frag 명령은 모든 파일 시스템 할당을 백분율로 표시되는 단일 조각화 번호로 중단하려고 합니다. 명령의 출력은 의미를 이해하기 위해 상당한 전문 지식이 필요합니다. 예를 들어 조각화 요인 75%는 파일당 평균 4개의 확장 영역만 의미합니다. 이러한 이유로 xfs_db의 frag의 출력은 유용하지 않으며 조각화 문제에 대한 보다 신중하게 분석하는 것이 좋습니다.주의xfs_fsr 명령을 사용하여 개별 파일 또는 파일 시스템의 모든 파일을 조각 모음할 수 있습니다. 나중에 파일의 로컬성을 제거하고 여유 공간을 조각 모음할 수 있으므로 특히 권장되지 않습니다.

3.10.1.1. ext3 및 ext4와 함께 사용되는 명령 XFS와 비교

표 3.1. ext3 및 ext4의 일반적인 명령 XFS와 비교

| Task | ext3/4 | XFS |

|---|---|---|

| 파일 시스템 생성 | mkfs.ext4 or mkfs.ext3 | mkfs.xfs |

| 파일 시스템 검사 | e2fsck | xfs_repair |

| 파일 시스템 크기 조정 | resize2fs | xfs_growfs |

| 파일 시스템 이미지 저장 | e2image | xfs_metadump and xfs_mdrestore |

| 파일 시스템에 레이블을 지정하거나 튜닝 | tune2fs | xfs_admin |

| 파일 시스템 백업 | 덤프 및 복원 | xfsdump 및 xfsrestore |

표 3.2. ext4 및 XFS용 일반 툴

| Task | ext4 | XFS |

|---|---|---|

| 할당량 | quota | xfs_quota |

| 파일 매핑 | filefrag | xfs_bmap |

4장. ext3 파일 시스템

- 가용성

- 예기치 않은 정전 또는 시스템 충돌(정확되지 않은 시스템 종료라고도 함) 후 시스템의 각 마운트된 ext2 파일 시스템은 e2fsck 프로그램에서 일관성을 확인해야 합니다. 이 프로세스는 특히 많은 수의 파일이 포함된 대용량의 경우 시스템 부팅 시간을 크게 지연시킬 수 있는 시간이 많이 걸리는 프로세스입니다. 이 시간 동안 볼륨의 모든 데이터에 연결할 수 없습니다.라이브 파일 시스템에서 fsck -n 을 실행할 수 있습니다. 그러나 이러한 변경 사항은 변경되지 않으며 부분적으로 작성된 메타데이터가 발생하는 경우 잘못된 결과를 초래할 수 있습니다.스택에서 LVM을 사용하는 경우 또 다른 옵션은 파일 시스템의 LVM 스냅샷을 찍고 대신 fsck 를 실행하는 것입니다.마지막으로 파일 시스템을 읽기 전용으로 다시 마운트할 수 있는 옵션이 있습니다. 그런 다음 모든 보류 중인 메타데이터 업데이트(및 쓰기)는 다시 마운트하기 전에 디스크에 강제 적용됩니다. 이렇게 하면 이전 손상이 없으므로 파일 시스템이 일관되게 유지됩니다. 이제 fsck -n 을 실행할 수 있습니다.ext3 파일 시스템에서 제공하는 저널링은 불명확한 시스템 종료 후 이러한 종류의 파일 시스템 점검이 더 이상 필요하지 않음을 의미합니다. ext3를 사용하여 일관성 검사가 발생하는 유일한 경우는 하드 드라이브 실패와 같은 드문 하드웨어 오류입니다. 불명확한 시스템 종료 후 ext3 파일 시스템을 복구하는 시간은 파일 시스템의 크기 또는 파일 수에 의존하지 않습니다. 오히려 일관성을 유지하는 데 사용되는 저널 의 크기에 따라 다릅니다. 기본 저널 크기는 하드웨어 속도에 따라 복구하는 데 약 1초가 걸립니다.참고Red Hat에서 지원하는 ext3에서 지원하는 유일한 저널링 모드는 data=ordered (기본값)입니다.

- 데이터 무결성

- ext3 파일 시스템은 불명확한 시스템 종료가 발생하는 경우 데이터 무결성의 손실을 방지합니다. ext3 파일 시스템을 사용하면 데이터를 수신하는 보호 유형 및 수준을 선택할 수 있습니다. 파일 시스템의 상태와 관련하여 ext3 볼륨은 기본적으로 높은 수준의 데이터 일관성을 유지하도록 구성됩니다.

- 속도

- 일부 데이터를 두 번 이상 작성하더라도 ext3은 ext3의 저널링을 하드 드라이브 헤드 동작을 최적화하기 때문에 대부분의 경우 ext2보다 처리량이 높습니다. 세 가지 저널링 모드 중에서 선택하여 속도를 최적화할 수 있지만 시스템이 실패하는 경우 데이터 무결성과 관련하여 절충을 의미합니다.참고Red Hat에서 지원하는 ext3에서 지원하는 유일한 저널링 모드는 data=ordered (기본값)입니다.

- 간편한 전환

- ext2에서 ext3로 쉽게 마이그레이션할 수 있으며, 다시 포맷하지 않고도 강력한 저널링 파일 시스템의 이점을 얻을 수 있습니다. 이 작업을 수행하는 방법에 대한 자세한 내용은 4.2절. “ext3 파일 시스템으로 변환” 을 참조하십시오.

ext4.ko 를 사용합니다. 즉, 커널 메시지는 사용된 ext 파일 시스템에 관계없이 항상 ext4를 참조합니다.

4.1. ext3 파일 시스템 생성

mkfs.ext3유틸리티를 사용하여 파티션 또는 LVM 볼륨을 ext3 파일 시스템으로 포맷합니다.#mkfs.ext3 block_device- block_device 를 블록 장치의 경로로 교체합니다. 예를 들어

/dev/sdb1,/dev/disk/by-uuid/05e99ec8-def1-4a5e-8a9d-59453ceb2a,/dev/my-volgroup/my-lv.

e2label유틸리티를 사용하여 파일 시스템에 레이블을 지정합니다.#e2label block_device volume_label

UUID 구성

-U 옵션을 사용합니다.

# mkfs.ext3 -U UUID device- UUID 를 설정할 UUID로 바꿉니다(예:

7cd65de3-e0be-41d9-b66d-96d749c02da7). - UUID를 추가할 수 있도록 device 를 ext3 파일 시스템의 경로로 바꿉니다(예:

/dev/sda8).

추가 리소스

- mkfs.ext3(8) 도움말 페이지

- e2label(8) 도움말 페이지

4.2. ext3 파일 시스템으로 변환

ext2 파일 시스템을 ext3 로 변환합니다.

ext2 파일 시스템을 ext3 로 변환하려면 root로 로그인하고 터미널에 다음 명령을 입력합니다.

# tune2fs -j block_device4.3. Ext2 파일 시스템으로 되돌리기

/dev/mapper/VolGroup00-LogVol02

절차 4.1. ext3에서 ext2로 되돌리기

- root로 로그인하고 다음을 입력하여 파티션을 마운트 해제합니다.

# umount /dev/mapper/VolGroup00-LogVol02 - 다음 명령을 입력하여 파일 시스템 유형을 ext2로 변경합니다.

# tune2fs -O ^has_journal /dev/mapper/VolGroup00-LogVol02 - 다음 명령을 입력하여 파티션에 오류를 확인합니다.

# e2fsck -y /dev/mapper/VolGroup00-LogVol02 - 그런 다음 다음을 입력하여 파티션을 ext2 파일 시스템으로 다시 마운트합니다.

# mount -t ext2 /dev/mapper/VolGroup00-LogVol02 /mount/point/mount/point 를 파티션의 마운트 지점으로 바꿉니다.참고파티션의 루트 수준에.journal파일이 있는 경우 삭제합니다.

/etc/fstab 파일을 업데이트해야 합니다. 그렇지 않으면 부팅 후 다시 되돌아갑니다.

5장. ext4 파일 시스템

- 주요 기능

- ext4 파일 시스템은 ext2 및 ext3에서 사용하는 기존 블록 매핑 체계와는 반대로 확장 기능을 사용하므로 대용량 파일을 사용할 때 성능이 향상되고 대용량 파일의 메타데이터 오버헤드가 감소합니다. 또한 ext4는 할당되지 않은 블록 그룹 및 inode 테이블 섹션에 레이블을 지정하여 파일 시스템 검사 중에 건너뛸 수 있습니다. 이렇게 하면 파일 시스템의 크기가 증가함에 따라 파일 시스템 점검이 빨라집니다.

- 할당 기능

- ext4 파일 시스템에는 다음과 같은 할당 체계가 있습니다.

- 영구 사전 할당

- 할당량 지연

- 다중 블록 할당

- 스트라이프 인식 할당

지연된 할당 및 기타 성능 최적화로 인해 ext4의 디스크에 파일 작성 동작이 ext3과 다릅니다. ext4에서는 프로그램이 파일 시스템에 쓸 때 프로그램이 나중에 fsync() 호출을 발행하지 않는 한 디스크상의 것이 보장되지 않습니다.기본적으로 ext3는 fsync() 를 사용하지 않고도 새로 생성된 파일을 즉시 디스크에 적용합니다. 이 동작은 fsync() 를 사용하지 않은 프로그램의 버그로 인해 기록된 데이터가 디스크에 있는지 확인합니다. 반면 ext4 파일 시스템은 종종 몇 초 동안 디스크에 변경 사항을 쓸 때까지 대기하여 ext3보다 더 나은 디스크 성능을 위해 쓰기를 결합하고 재정렬할 수 있습니다.주의ext3과 달리 ext4 파일 시스템은 트랜잭션 커밋 시 데이터를 디스크에 강제 적용하지 않습니다. 따라서 버퍼링된 쓰기가 디스크에 플러시되는 데 시간이 더 오래 걸립니다. 모든 파일 시스템과 마찬가지로 fsync() 와 같은 데이터 무결성 호출을 사용하여 데이터가 영구 스토리지에 작성되었는지 확인합니다. - 기타 ext4 기능

- ext4 파일 시스템은 다음과 같은 기능도 지원합니다.

- 확장 속성 (

xattr) - 이를 통해 시스템은 파일당 여러 개의 추가 이름 및 값 쌍을 연결할 수 있습니다. - 할당량 저널링 - 충돌 후 긴 할당량 일관성 검사가 필요하지 않습니다.참고ext4에서 지원되는 유일한 저널링 모드는 data=ordered (기본값)입니다.

- 하위 시간 타임스탬프 - 이 명령은 타임스탬프를 서브초에 제공합니다.

5.1. ext4 파일 시스템 생성

- ext4 파일 시스템을 생성하려면 다음 명령을 사용합니다.

#mkfs.ext4 block_device- block_device 를 블록 장치의 경로로 교체합니다. 예를 들어

/dev/sdb1,/dev/disk/by-uuid/05e99ec8-def1-4a5e-8a9d-59453ceb2a,/dev/my-volgroup/my-lv. - 일반적으로 기본 옵션은 대부분의 사용 시나리오에 적합합니다.

예 5.1. mkfs.ext4 명령 출력

~]# mkfs.ext4 /dev/sdb1

mke2fs 1.41.12 (17-May-2010)

Filesystem label=

OS type: Linux

Block size=4096 (log=2)

Fragment size=4096 (log=2)

Stride=0 blocks, Stripe width=0 blocks

245280 inodes, 979456 blocks

48972 blocks (5.00%) reserved for the super user

First data block=0

Maximum filesystem blocks=1006632960

30 block groups

32768 blocks per group, 32768 fragments per group

8176 inodes per group

Superblock backups stored on blocks:

32768, 98304, 163840, 229376, 294912, 819200, 884736

Writing inode tables: done

Creating journal (16384 blocks): done

Writing superblocks and filesystem accounting information: done

사용되지 않는 블록 장치

- stride=value

- RAID 청크 크기를 지정합니다.

- stripe-width=value

- RAID 장치의 데이터 디스크 수 또는 스트라이프의 스트라이프 단위 수를 지정합니다.

# mkfs.ext4 -E stride=16,stripe-width=64 /dev/block_deviceUUID 구성

-U 옵션을 사용합니다.

# mkfs.ext4 -U UUID device- UUID 를 설정할 UUID로 바꿉니다(예:

7cd65de3-e0be-41d9-b66d-96d749c02da7). - UUID를 추가할 수 있도록 device 를 ext4 파일 시스템의 경로로 바꿉니다(예:

/dev/sda8).

추가 리소스

- mkfs.ext4(8) 도움말 페이지

5.2. ext4 파일 시스템 마운트

# mount /dev/device /mount/point

# mount -o acl,user_xattr /dev/device /mount/point

# mount -o data_err=abort /dev/device /mount/point5.2.1. 쓰기 Barriers

# mount -o nobarrier /dev/device /mount/point5.2.2. 직접 액세스 기술 프리뷰

직접 액세스 )는 ext4 및 XFS 파일 시스템에서 기술 프리뷰로 제공합니다. 즉 애플리케이션이 영구 메모리를 주소 공간에 직접 매핑하는 수단입니다. DAX를 사용하려면 일반적으로 하나 이상의 비접근 다각형 메모리 모듈(NVDIMM) 및 DAX를 지원하는 파일 시스템을 NVDIMM(NVDIMM)에서 시스템에서 사용할 수 있는 일종의 영구 메모리가 있어야 합니다. 또한 dax 마운트 옵션을 사용하여 파일 시스템을 마운트해야 합니다. 그런 다음 dax-mounted 파일 시스템에 있는 파일의 mmap 을 애플리케이션 주소 공간에 직접 매핑합니다.

5.3. ext4 파일 시스템 크기 조정

# resize2fs /mount/device size

# resize2fs /dev/device size- s - 512바이트 섹터

- K — kilobytes

- m - 메가바이트

- g - 기가바이트

5.4. ext2, ext3 또는 ext4 파일 시스템 백업

사전 요구 사항

- 시스템이 오랫동안 실행 중인 경우 백업 전에 파티션에서

e2fsck유틸리티를 실행합니다.#e2fsck /dev/device

절차 5.1. ext2, ext3 또는 ext4 파일 시스템 백업

/etc/fstab파일의 내용 및 metadata -l 명령의 출력을 포함한 구성 정보를 백업합니다. 이는 파티션을 복원하는 데 유용합니다.이 정보를 캡처하려면sosreport또는sysreport유틸리티를 실행합니다.sosreport에 대한 자세한 내용은 What is a sosreport and how to create one in Red Hat Enterprise Linux 4.6 이상에서참조하십시오. Kdowledgebase 문서.- 파티션 역할에 따라:

- 백업 중인 파티션이 운영 체제 파티션인 경우 시스템을 복구 모드로 부팅합니다. 시스템 관리자 가이드의 Booting to Rescue Mode 섹션을 참조하십시오.

- 정규 데이터 파티션을 백업할 때 마운트 해제합니다.데이터 파티션이 마운트되는 동안 데이터 파티션을 백업할 수는 있지만 마운트된 데이터 파티션을 백업한 결과를 예측할 수 없습니다.

dump유틸리티를 사용하여 마운트된 파일 시스템을 백업해야 하는 경우 파일 시스템이 과도하게 로드되지 않을 때 이 작업을 수행합니다. 백업 시 파일 시스템에서 작업이 많을수록 백업 손상 위험이 높아집니다.

덤프유틸리티를 사용하여 파티션의 내용을 백업합니다.#dump -0uf backup-file /dev/devicebackup-file 을 백업을 저장할 파일의 경로로 바꿉니다. 장치를 백업하려는 ext4 파티션의 이름으로 바꿉니다. 백업 중인 파티션과 다른 파티션에 마운트된 디렉터리에 백업을 저장해야 합니다.예 5.2. 여러 ext4 파티션 백업

/dev/sda1,/dev/sda2파티션의 내용을/backup-files/#dump -0uf /backup-files/sda1.dump /dev/sda1#dump -0uf /backup-files/sda2.dump /dev/sda2#dump -0uf /backup-files/sda3.dump /dev/sda3원격 백업을 수행하려면ssh유틸리티를 사용하거나 암호 없는ssh로그인을 설정합니다.ssh및 암호 없는 로그인에 대한 자세한 내용은 시스템 관리자 가이드 의 ssh 유틸리티 사용 및 키 기반 인증 사용 섹션을 참조하십시오.예를 들어ssh를 사용하는 경우 다음을 수행합니다.예 5.3.

ssh를 사용하여 원격 백업 수행#dump -0u -f - /dev/device | ssh root@remoteserver.example.com dd of=backup-file표준 리디렉션을 사용하는 경우-f옵션을 별도로 전달해야 합니다.

5.4.1. 추가 리소스

- 자세한 내용은 dump(8) 도움말 페이지를 참조하십시오.

5.5. ext2, ext3 또는 ext4 파일 시스템 복원

사전 요구 사항

- 5.4절. “ext2, ext3 또는 ext4 파일 시스템 백업” 에 설명된 대로 파티션 및 해당 메타데이터 백업이 필요합니다.

절차 5.2. ext2, ext3 또는 ext4 파일 시스템 복원

- 운영 체제 파티션을 복원하는 경우 시스템을 복구 모드로 부팅합니다. 시스템 관리자 가이드의 Booting to Rescue Mode 섹션을 참조하십시오.이 단계는 일반 데이터 파티션에 필요하지 않습니다.

fdisk또는partedutilites를 사용하여 복원할 파티션을 다시 빌드합니다.파티션이 더 이상 존재하지 않으면 다시 생성합니다. 새 파티션은 복원된 데이터를 포함할 수 있을 만큼 충분히 커야 합니다. 시작 및 끝 번호를 올바르게 얻는 것이 중요합니다. 이는 백업 시 metadata 유틸리티에서 얻은 파티션의 시작 및 끝 번호입니다.파티션 수정에 대한 자세한 내용은 다음을 참조하십시오. 13장. 파티션mkfs유틸리티를 사용하여 대상 파티션을 포맷합니다.#mkfs.ext4 /dev/device중요백업 파일을 저장하는 파티션을 포맷 하지 마십시오.- 새 파티션을 생성한 경우 모든 파티션을 다시 레이블이

/etc/fstab파일의 해당 항목과 일치하도록 합니다.#e2label /dev/device label - 임시 마운트 지점을 생성하고 여기에 파티션을 마운트합니다.

#mkdir /mnt/device#mount -t ext4 /dev/device /mnt/device - 마운트된 파티션의 백업에서 데이터를 복원합니다.

#cd /mnt/device#restore -rf device-backup-file원격 시스템에 복원하거나 원격 호스트에 저장된 백업 파일에서 복원하려면ssh유틸리티를 사용할 수 있습니다.ssh에 대한 자세한 내용은 시스템 관리자 가이드 의 ssh 유틸리티 사용 섹션을 참조하십시오.다음 명령에 대해 암호 없이 로그인을 구성해야 합니다. 암호가 없는ssh로그인을 설정하는 방법에 대한 자세한 내용은 시스템 관리자 가이드의 키 기반 인증 사용 섹션을 참조하십시오.- 동일한 머신에 저장된 백업 파일에서 원격 머신의 파티션을 복원하려면 다음을 수행합니다.

#ssh remote-address "cd /mnt/device && cat backup-file | /usr/sbin/restore -r -f -" - 다른 원격 머신에 저장된 백업 파일에서 원격 머신의 파티션을 복원하려면 다음을 수행합니다.

#ssh remote-machine-1 "cd /mnt/device && RSH=/usr/bin/ssh /usr/sbin/restore -rf remote-machine-2:backup-file"

- reboot:

#systemctl reboot

예 5.4. 여러 ext4 파티션 복원

- fdisk 명령을 사용하여 복원할 파티션을 다시 작성합니다.

- 대상 파티션을 포맷합니다.

#mkfs.ext4 /dev/sda1#mkfs.ext4 /dev/sda2#mkfs.ext4 /dev/sda3 /etc/fstab파일과 일치하도록 모든 파티션에 레이블을 다시 지정합니다.#e2label /dev/sda1 Boot1#e2label /dev/sda2 Root#e2label /dev/sda3 Data- 작업 디렉터리를 준비합니다.새 파티션을 마운트합니다.

#mkdir /mnt/sda1#mount -t ext4 /dev/sda1 /mnt/sda1#mkdir /mnt/sda2#mount -t ext4 /dev/sda2 /mnt/sda2#mkdir /mnt/sda3#mount -t ext4 /dev/sda3 /mnt/sda3백업 파일이 포함된 파티션을 마운트합니다.#mkdir /backup-files#mount -t ext4 /dev/sda6 /backup-files - 백업에서 마운트된 파티션으로 데이터를 복원합니다.

#cd /mnt/sda1#restore -rf /backup-files/sda1.dump#cd /mnt/sda2#restore -rf /backup-files/sda2.dump#cd /mnt/sda3#restore -rf /backup-files/sda3.dump - reboot:

#systemctl reboot

추가 리소스

- 자세한 내용은 restore(8) 도움말 페이지를 참조하십시오.

5.6. 기타 ext4 파일 시스템 유틸리티

- e2fsck

- ext4 파일 시스템을 복구하는 데 사용됩니다. 이 툴은 ext4 디스크 구조의 업데이트 때문에 ext3보다 더 효율적으로 ext4 파일 시스템을 점검하고 복구합니다.

- e2label

- ext4 파일 시스템에서 레이블을 변경합니다. 이 도구는 ext2 및 ext3 파일 시스템에서도 작동합니다.

- 할당량

- ext4 파일 시스템에서 사용자와 그룹이 디스크 공간(블록) 및 파일(inode) 사용을 제어하고 보고합니다. 할당량 사용에 대한 자세한 내용은 man 할당량 및 17.1절. “디스크 할당량 구성” 을 참조하십시오.

- fsfreeze

- 파일 시스템에 대한 액세스를 일시 중지하려면 # fsfreeze -f 마운트 지점 을 사용하여 정지하고 # fsfreeze -u 마운트 -u 마운트 지점 을 해제하십시오. 이렇게 하면 파일 시스템에 대한 액세스가 중단되고 디스크에 안정적인 이미지가 생성됩니다.참고장치 매퍼 드라이브에 fsfreeze 를 사용하는 것은 불필요합니다.자세한 내용은 fsfreeze(8) 매뉴얼 페이지를 참조하십시오.

- debugfs

- ext2, ext3 또는 ext4 파일 시스템을 디버깅합니다.

- e2image

- 중요한 ext2, ext3 또는 ext4 파일 시스템 메타데이터를 파일에 저장합니다.

6장. 1.8.0 (기술 프리뷰)

6.1. btrfs 파일 시스템 생성

# mkfs.btrfs /dev/device6.2. btrfs 파일 시스템 마운트

# mount /dev/device /mount-point

- device=/dev/name

- mount 명령에 이 옵션을 추가하면 btrfs 볼륨에 대해 이름이 지정된 장치를 검사하도록 btrfs가 지시합니다. btrfs가 아닌 장치를 마운트하려고 하면 마운트가 실패하는 것을 확인하는 데 사용됩니다.참고따라서 모든 장치가 파일 시스템에 추가되는 것은 아니며 파일 시스템에만 스캔합니다.

- max_inline=number

- 메타데이터 B-트리 리프 내에서 인라인 데이터에 사용할 수 있는 최대 공간(바이트 단위)을 설정하려면 이 옵션을 사용합니다. 기본값은 8192바이트입니다. 4k 페이지의 경우 리프에 적합해야 하는 추가 헤더로 인해 3900바이트로 제한됩니다.

- alloc_start=number

- 디스크 할당이 시작되는 위치를 설정하려면 이 옵션을 사용합니다.

- thread_pool=number

- 할당된 작업자 스레드 수를 할당하려면 이 옵션을 사용합니다.

- 삭제

- 여유 블록에서 discard/TRIM을 활성화하려면 이 옵션을 사용합니다.

- noacl

- 이 옵션을 사용하여 ACL의 사용을 비활성화합니다.

- space_cache

- 블록 그룹을 더 빠르게 캐싱하려면 이 옵션을 사용하여 사용 가능한 공간 데이터를 디스크에 저장합니다. 이는 영구적 변경 사항이며 이전 커널로 부팅하는 것이 안전합니다.

- nospace_cache

- 위의 space_cache 를 비활성화하려면 이 옵션을 사용합니다.

- clear_cache

- 마운트 중에 사용 가능한 모든 공간 캐시를 지우려면 이 옵션을 사용합니다. 이 옵션은 안전한 옵션이지만 공간 캐시를 다시 빌드하도록 트리거합니다. 따라서 다시 빌드 프로세스를 완료할 수 있도록 파일 시스템을 마운트된 상태로 둡니다. 이 마운트 옵션은 한 번만 사용되며 사용 가능한 공간에 문제가 표시된 후에만 사용됩니다.

- enospc_debug

- 이 옵션은 "공간이 남아 있지 않음"과 관련된 문제를 디버그하는 데 사용됩니다.

- 복구

- 마운트 시 자동 복구 기능을 사용하려면 이 옵션을 사용합니다.

6.3. btrfs 파일 시스템 크기 조정

6.3.1. btrfs 파일 시스템 등록

# btrfs filesystem resize amount /mount-point

# btrfs filesystem resize +200M /btrfssingle Resize '/btrfssingle' of '+200M'

# btrfs filesystem show /mount-point

# btrfs filesystem show /btrfstest Label: none uuid: 755b41b7-7a20-4a24-abb3-45fdbed1ab39 Total devices 4 FS bytes used 192.00KiB devid 1 size 1.00GiB used 224.75MiB path /dev/vdc devid 2 size 524.00MiB used 204.75MiB path /dev/vdd devid 3 size 1.00GiB used 8.00MiB path /dev/vde devid 4 size 1.00GiB used 8.00MiB path /dev/vdf Btrfs v3.16.2

devid 를 확인한 후 다음 명령을 사용합니다.

# btrfs filesystem resize devid:amount /mount-point

# btrfs filesystem resize 2:+200M /btrfstest Resize '/btrfstest/' of '2:+200M'

6.3.2. btrfs 파일 시스템 축소

# btrfs filesystem resize amount /mount-point

# btrfs filesystem resize -200M /btrfssingle Resize '/btrfssingle' of '-200M'

# btrfs filesystem show /mount-point

# btrfs filesystem show /btrfstest Label: none uuid: 755b41b7-7a20-4a24-abb3-45fdbed1ab39 Total devices 4 FS bytes used 192.00KiB devid 1 size 1.00GiB used 224.75MiB path /dev/vdc devid 2 size 524.00MiB used 204.75MiB path /dev/vdd devid 3 size 1.00GiB used 8.00MiB path /dev/vde devid 4 size 1.00GiB used 8.00MiB path /dev/vdf Btrfs v3.16.2

devid 를 확인한 후 다음 명령을 사용합니다.

# btrfs filesystem resize devid:amount /mount-point

# btrfs filesystem resize 2:-200M /btrfstest Resize '/btrfstest' of '2:-200M'

6.3.3. 파일 시스템 크기 설정

# btrfs filesystem resize amount /mount-point

# btrfs filesystem resize 700M /btrfssingle Resize '/btrfssingle' of '700M'

# btrfs filesystem show /mount-point

# btrfs filesystem show /btrfstest Label: none uuid: 755b41b7-7a20-4a24-abb3-45fdbed1ab39 Total devices 4 FS bytes used 192.00KiB devid 1 size 1.00GiB used 224.75MiB path /dev/vdc devid 2 size 724.00MiB used 204.75MiB path /dev/vdd devid 3 size 1.00GiB used 8.00MiB path /dev/vde devid 4 size 1.00GiB used 8.00MiB path /dev/vdf Btrfs v3.16.2

devid 를 확인한 후 다음 명령을 사용합니다.

# btrfs filesystem resize devid:amount /mount-point

# btrfs filesystem resize 2:300M /btrfstest Resize '/btrfstest' of '2:300M'

6.4. 여러 장치에 대한 통합 볼륨 관리

6.4.1. 여러 장치가 있는 파일 시스템 생성

- raid0

- raid1

- raid10

- DUP

- single

예 6.1. RAID 10 btrfs 파일 시스템 생성

# mkfs.btrfs /dev/device1 /dev/device2 /dev/device3 /dev/device4

# mkfs.btrfs -m raid0 /dev/device1 /dev/device2

# mkfs.btrfs -m raid10 -d raid10 /dev/device1 /dev/device2 /dev/device3 /dev/device4

# mkfs.btrfs -m single /dev/device

# mkfs.btrfs -d single /dev/device1 /dev/device2 /dev/device3

# btrfs device add /dev/device1 /mount-point

6.4.2. btrfs 장치 검색

/dev 에서 모든 블록 장치를 검사하고 btrfs 볼륨을 검색합니다. 파일 시스템에서 둘 이상의 장치로 실행하는 경우 btrfs 모듈을 로드한 후 수행해야 합니다.

# btrfs device scan

# btrfs device scan /dev/device

6.4.3. btrfs 파일 시스템에 새 장치 추가

예 6.2. btrfs 파일 시스템에 새 장치 추가

# mkfs.btrfs /dev/device1 # mount /dev/device1

# btrfs device add /dev/device2 /mount-point

/dev/device1 에만 저장됩니다. 이제 모든 장치에 분산되도록 균형을 조정해야 합니다.

# btrfs filesystem balance /mount-point

6.4.4. btrfs 파일 시스템 변환

예 6.3. btrfs 파일 시스템 변환

/dev/sdb1 을 단일 디스크 장애로부터 보호하기 위해 raid1 시스템이 두 개의 장치로 변환하려면 다음 명령을 사용합니다.

# mount /dev/sdb1 /mnt # btrfs device add /dev/sdc1 /mnt # btrfs balance start -dconvert=raid1 -mconvert=raid1 /mnt

6.4.5. btrfs 장치 제거

예 6.4. btrfs 파일 시스템에서 장치 제거

# mkfs.btrfs /dev/sdb /dev/sdc /dev/sdd /dev/sde # mount /dev/sdb /mnt

# btrfs device delete /dev/sdc /mnt

6.4.6. btrfs 파일 시스템에서 실패한 장치 교체

# mkfs.btrfs -m raid1 /dev/sdb /dev/sdc /dev/sdd /dev/sde ssd is destroyed or removed, use -o degraded to force the mount to ignore missing devices # mount -o degraded /dev/sdb /mnt 'missing' is a special device name # btrfs device delete missing /mnt

- 성능 저하 모드에서 마운트

- 새 장치를 추가하고,

- 및 누락된 장치를 제거합니다.

6.4.7. /etc/fstab에 btrfs 파일 시스템 등록

initrd 가 없거나 btrfs 장치 검사를 수행하지 않은 경우 파일 시스템의 모든 장치를 마운트 명령에 명시적으로 전달하여 다중 볼륨 btrfs 파일 시스템을 마운트 할 수 있습니다.

예 6.5. /etc/fstab Entry의 예

/etc/fstab 항목의 예는 다음과 같습니다.

/dev/sdb /mnt btrfs device=/dev/sdb,device=/dev/sdc,device=/dev/sdd,device=/dev/sde 0

6.5. SSD 최적화

mkfs.btrfs 가 단일 장치에서 메타데이터 중복을 끄는 것입니다. /sys/block/device/queue/rotational 이 지정된 단일 장치의 경우 0입니다. 명령줄에서 -m single 을 지정하는 것과 동일합니다. m dup 옵션을 제공하여 강제된 메타데이터와 중복 메타데이터를 재정의할 수 있습니다. 두 복사본을 손실 할 수있는 SSD 펌웨어로 인해 중복이 필요하지 않습니다. 이로 인해 공간을 소비하고 성능 비용이 절약됩니다.

- 이를 통해 더 큰 메타데이터 클러스터 할당이 가능합니다.

- 가능한 경우 데이터를 더 순차적으로 할당합니다.

- 키 및 블록 순서와 일치하도록 btree leaf rewriting을 비활성화합니다.

- 여러 프로세스를 배치하지 않고 로그 조각을 커밋합니다.

6.6. tested 참고 사항

- 스냅샷을 관리하기 위한 모든 subvolume 명령.

장치관리를 위한 장치 명령입니다.- scrub,balance 및 fragment 명령

7장. 글로벌 파일 시스템 2

gfs2.ko 커널 모듈은 GFS2 파일 시스템을 구현하고, GFS2 클러스터 노드에 로드됩니다.

8장. 네트워크 파일 시스템(NFS)

8.1. NFS 소개

- NFS 버전 3(NFSv3)은 안전한 비동기 쓰기를 지원하며 이전 NFSv2보다 오류 처리에서 더 강력합니다. 또한 64비트 파일 크기 및 오프셋을 지원하므로 클라이언트가 2GB 이상의 파일 데이터에 액세스할 수 있습니다.

- NFS 버전 4(NFSv4)는 방화벽과 인터넷에서 작동하므로 더 이상 alice bind 서비스가 필요하지 않으며 ACL을 지원하며 상태 저장 작업을 사용할 수 있습니다.

- 스파스 파일: 파일의 공간 효율성을 확인하고 자리 표시자를 사용하여 스토리지 효율성을 개선할 수 있습니다. 하나 이상의 홀이 있는 파일이며, 허자는 할당되지 않았거나 초기화되지 않은 데이터 블록은 0으로만 구성됩니다.

lseek()NFSv4.2의 작업은seek_hole()및seek_data()을 지원하므로 애플리케이션이 스파스 파일에 있는 허위의 위치를 매핑할 수 있습니다. - 공간 예약: 스토리지 서버가 여유 공간을 예약하여 서버가 공간을 비우는 것을 방지할 수 있습니다. NFSv4.2에서는

allocate()작업을 통해 예약할 수 있는deallocate()작업, 예약되지 않은 공간 및fallocate()작업을 통해 파일에 공간을 사전 할당하거나 할당 해제할 수 있습니다. - 레이블이 지정된 NFS: 데이터 액세스 권한을 적용하고 NFS 파일 시스템의 개별 파일에 대해 클라이언트와 서버 간에 SELinux 레이블을 활성화합니다.

- 레이아웃 기능 향상: NFSv4.2는 클라이언트가 레이아웃과의 통신에 대해 메타데이터 서버에 알리는 데 사용할 수 있는 새로운 작업인

layoutstats()를 제공합니다.

- 네트워크의 성능 및 보안을 강화하고 PNFS(Parallel NFS)에 대한 클라이언트 측 지원도 포함됩니다.

- 더 이상 콜백에 대한 별도의 TCP 연결이 필요하지 않으므로, NFS 서버에서 클라이언트에 연결할 수 없는 경우에도 위임을 부여할 수 있습니다. 예를 들어 NAT 또는 방화벽이 간섭하는 경우입니다.

- 이는 정확히 한 번 의미 체계(재부팅 작업 제외)를 제공하여 응답이 손실되고 작업이 두 번 전송되는 경우 특정 작업에서 부정확한 결과를 반환할 수 있는 이전 문제를 방지합니다.

/etc/exports 구성 파일을 참조하여 클라이언트가 내보낸 파일 시스템에 액세스할 수 있는지 여부를 확인합니다. 확인되면 모든 파일 및 디렉터리 작업을 사용자가 사용할 수 있습니다.

8.1.1. 필수 서비스

- nfs

- systemctl start nfs 는 NFS 서버를 시작하고 적절한 RPC 프로세스는 공유 NFS 파일 시스템에 대한 요청을 서비스합니다.

- nfslock

- systemctl start nfs-lock 은 NFS 클라이언트가 서버에 파일을 잠글 수 있도록 적절한 RPC 프로세스를 시작하는 필수 서비스를 활성화합니다.

- rpcbind

- Diffiebind 는 로컬 RPC 서비스의 포트 예약을 허용합니다. 그런 다음 이러한 포트를 사용할 수 있도록 (또는 광고)하여 해당 원격 RPC 서비스에서 액세스할 수 있습니다. INPUTbind 는 RPC 서비스 요청에 응답하고 요청된 RPC 서비스에 대한 연결을 설정합니다. NFSv4에서는 사용되지 않습니다.

- rpc.mountd

- 이 프로세스는 NFS 서버에서 NFSv3 클라이언트의 MOUNT 요청을 처리하는 데 사용됩니다. 요청된 NFS 공유가 현재 NFS 서버에서 내보내고 클라이언트가 액세스할 수 있는지 확인합니다. 마운트 요청이 허용되면 EgressIP.mountd 서버는

Success상태로 응답하고 이 NFS 공유에 대한File-Handle을 NFS 클라이언트에 다시 제공합니다. - rpc.nfsd

- RPC.nfsd 를 사용하면 명시적 NFS 버전 및 서버에서 알리는 프로토콜을 정의할 수 있습니다. NFS 클라이언트가 연결할 때마다 서버 스레드를 제공하는 등 NFS 클라이언트의 동적 요구사항을 충족하기 위해 Linux 커널과 함께 작동합니다. 이 프로세스는 nfs 서비스에 해당합니다.

- lockd

- lockd 는 클라이언트와 서버에서 모두 실행되는 커널 스레드입니다. NFSv3 클라이언트가 서버에 파일을 잠글 수 있도록 하는 NLM( Network Lock Manager ) 프로토콜을 구현합니다. NFS 서버가 실행될 때마다 NFS 파일 시스템이 마운트될 때마다 자동으로 시작됩니다.

- rpc.statd

- 이 프로세스에서는 NSM( Network Status Monitor ) RPC 프로토콜을 구현하므로 NFS 서버가 정상적으로 시작되지 않을 때 NFS 서버를 다시 시작할 때 NFS 클라이언트에 알립니다. RPC.statd 는 nfslock 서비스에 의해 자동으로 시작되며 사용자 구성이 필요하지 않습니다. NFSv4에서는 사용되지 않습니다.

- rpc.rquotad

- 이 프로세스는 원격 사용자에 대한 사용자 할당량 정보를 제공합니다. RPC.rquotad 는 nfs 서비스에서 자동으로 시작하며 사용자 구성이 필요하지 않습니다.

- rpc.idmapd

- RPC .idmapd 는 NFSv4 클라이언트와 서버 upcalls를 제공합니다. 이 호출은 유선 NFSv4 이름(

user@domain형식의 문자열)과 로컬 UID 및 GID 간에 매핑됩니다. idmapd 가 NFSv4에서 작동하려면/etc/idmapd.conf파일을 구성해야 합니다. 최소한 NFSv4 매핑 도메인을 정의하는 "Domain" 매개변수를 지정해야 합니다. NFSv4 매핑 도메인이 DNS 도메인 이름과 동일한 경우 이 매개 변수를 건너뛸 수 있습니다. ID가 올바르게 작동하려면 클라이언트와 서버는 NFSv4 매핑 도메인에 동의해야 합니다.참고Red Hat Enterprise Linux 7에서 NFSv4 서버만 INPUT .idmapd 를 사용합니다. NFSv4 클라이언트는 인증 키 기반 idmapper nfsidmap 을 사용합니다. nfsidmap 은 ID 매핑을 수행하기 위해 커널 온-요청에 의해 호출되는 독립형 프로그램입니다. 이는 데몬이 아닙니다. nfsidmap 에 문제가 있는 경우 클라이언트가 EgressIP .idmapd를 사용하여 대체합니다. nfsidmap 에 대한 자세한 내용은 nfsidmap 매뉴얼 페이지에서 확인할 수 있습니다.

8.2. NFS 클라이언트 구성

# mount -t nfs -o options server:/remote/export /local/directory- options

- 쉼표로 구분된 마운트 옵션 목록. 유효한 NFS 마운트 옵션에 대한 자세한 내용은 8.4절. “일반적인 NFS 마운트 옵션” 의 내용을 참조하십시오.

- server

- 마운트하려는 파일 시스템을 내보내는 서버의 호스트 이름, IP 주소 또는 정규화된 도메인 이름

- /remote/export

- 서버에서 내보낼 파일 시스템 또는 디렉터리, 즉 마운트하려는 디렉터리입니다.

- /local/directory

- /remote/export 가 마운트된 클라이언트 위치

/etc/fstab 파일과 autofs 서비스를 제공합니다. 자세한 내용은 8.2.1절. “/etc/fstab을 사용하여 NFS 파일 시스템 마운트” 및 8.3절. “flexs” 을 참조하십시오.

8.2.1. /etc/fstab을 사용하여 NFS 파일 시스템 마운트

/etc/fstab 파일에 행을 추가하는 것입니다. 행은 NFS 서버의 호스트 이름, 내보낼 서버의 디렉터리 및 NFS 공유를 마운트할 로컬 시스템의 디렉터리를 지정해야 합니다. /etc/fstab 파일을 수정하려면 root여야 합니다.

예 8.1. 구문 예

/etc/fstab 행의 일반적인 구문은 다음과 같습니다.

server:/usr/local/pub /pub nfs defaults 0 0

/pub 가 클라이언트 시스템에 있어야 합니다. 클라이언트 시스템의 /etc/fstab 에 이 행을 추가한 후 mount /pub 명령을 사용하고 /pub 마운트 지점 /pub 는 서버에서 마운트됩니다.

/etc/fstab 항목에 다음 정보가 포함되어야 합니다.

server:/remote/export /local/directory nfs options 0 0

/etc/fstab 를 읽기 전에 클라이언트에 있어야 합니다. 그렇지 않으면 마운트가 실패합니다.

/etc/fstab 을 편집한 후 시스템에서 새 구성을 등록하도록 마운트 장치를 다시 생성합니다.

# systemctl daemon-reload추가 리소스

/etc/fstab에 대한 자세한 내용은 man fstab 을 참조하십시오.

8.3. flexs

/etc/fstab 를 사용하는 한 가지 단점은 마운트된 파일 시스템을 유지하기 위해 리소스를 전용으로 지정해야 한다는 것입니다. 이는 하나 또는 두 개의 마운트에 문제가 아니지만 한 번에 여러 시스템에 마운트를 유지하는 경우 전체 시스템 성능에 영향을 줄 수 있습니다. /etc/fstab 대신 커널 기반 자동 마운트 유틸리티를 사용하는 것입니다. 자동 마운터는 다음 두 가지 구성 요소로 구성됩니다.

- 파일 시스템을 구현하는 커널 모듈, 및

- 기타 모든 기능을 수행하는 사용자 공간 데몬.

/etc/auto.master (마스터 맵)를 기본 기본 설정 파일로 사용합니다. Name Service Switch(NSS) 메커니즘과 함께 autofs 구성( /etc/sysconfig/autofs)을 사용하여 지원되는 다른 네트워크 소스와 이름을 사용하도록 변경할 수 있습니다. autofs 버전 4 데몬의 인스턴스는 마스터 맵에 구성된 각 마운트 지점에 대해 실행되었으며 지정된 마운트 지점에 대해 명령줄에서 수동으로 실행할 수 있습니다. autofs 버전 5에서는 단일 데몬을 사용하여 구성된 모든 마운트 지점을 관리하기 때문에 이 작업을 수행할 수 없습니다. 따라서 모든 자동 마운트를 마스터 맵에서 구성해야 합니다. 이는 다른 업계 표준 자동 마운터의 일반적인 요구 사항과 일치합니다. 마운트 지점, 호스트 이름, 내보낸 디렉터리 및 옵션은 각 호스트에 대해 수동으로 구성하는 대신 파일 집합(또는 기타 지원되는 네트워크 소스)에서 모두 지정할 수 있습니다.

8.3.1. 버전 4를 통한 autofs 버전 5 개선 사항

- 직접 맵 지원

- autofs 의 직접 맵은 파일 시스템 계층 구조의 임의의 지점에서 파일 시스템을 자동으로 마운트하는 메커니즘을 제공합니다. 직접 맵은 마스터 맵의 마운트 지점

/-로 표시됩니다. 직접 맵의 항목에는 절대 경로 이름이 키로 포함됩니다(직모 맵에서 사용되는 상대 경로 이름 대신). - 지연 마운트 및 마운트 해제 지원

- 다중 마운트 맵 항목은 단일 키 아래의 마운트 지점 계층을 설명합니다. 이에 대한 좋은 예는

-hosts맵이며, 일반적으로/net/에 있는 호스트의 모든 내보내기를 다중 마운트 맵 항목으로 자동 마운트하는 데 사용됩니다.-hosts맵을 사용하는 경우 ls of /net/host는 호스트 에서 각 내보내기에 대해 autofs 트리거 마운트를 마운트합니다. 그러면 액세스 시 마운트 및 만료됩니다. 이렇게 하면 대량의 내보내기가 있는 서버에 액세스하는 경우 필요한 활성 마운트 수를 크게 줄일 수 있습니다. - LDAP 지원 강화

- autofs 설정 파일(

/etc/sysconfig/autofs)은 사이트에서 구현하는 autofs 스키마를 지정하는 메커니즘을 제공하므로 애플리케이션 자체의 평가판 및 오류를 통해 이를 결정해야 합니다. 또한 공통 LDAP 서버 구현에서 지원하는 대부분의 메커니즘을 사용하여 LDAP 서버에 인증된 바인딩이 지원됩니다. 이러한 지원을 위해 새로운 설정 파일이 추가되었습니다./etc/autofs_ldap_auth.conf. 기본 구성 파일은 자체 문서화되며 XML 형식을 사용합니다. - Name Service Switch(nsswitch) 구성을 올바르게 사용합니다.

- Name Service Switch 구성 파일은 특정 구성 데이터가 제공되는 위치를 결정하는 수단을 제공하기 위해 존재합니다. 이 구성의 이유는 관리자가 선택한 백엔드 데이터베이스를 사용하는 동시에 데이터에 액세스할 수 있는 균일한 소프트웨어 인터페이스를 유지하는 유연성을 제공하기 위한 것입니다. NSS 설정을 처리할 때 버전 4 자동 마운터가 점점 더 높아지고 있지만 아직 완료되지 않았습니다. 반면, Libv 버전 5는 완전한 구현입니다.이 파일의 지원되는 구문에 대한 자세한 내용은 man nsswitch.conf 를 참조하십시오. 모든 NSS 데이터베이스가 유효한 맵 소스는 아니며, 구문 분석기에서 유효하지 않은 맵을 거부합니다. 유효한 소스는 파일, yp,nis,nisplus,ldap, hesiod 입니다.

- autofs 마운트 지점당 여러 마스터 맵 항목

- 자주 사용되지만 아직 언급되지 않은 한 가지는 직접 마운트 지점(

/-)에 대해 여러 개의 마스터 맵 항목을 처리하는 것입니다. 각 항목의 맵 키는 병합되고 하나의 맵으로 작동합니다.예 8.2. autofs 마운트 지점당 다중 마스터 맵 항목

다음은 직접 마운트를 위한 connectathon 테스트 맵의 예입니다./- /tmp/auto_dcthon /- /tmp/auto_test3_direct /- /tmp/auto_test4_direct

8.3.2. autofs 설정

/etc/auto.master 이며, 8.3.1절. “버전 4를 통한 autofs 버전 5 개선 사항” 에 설명된 대로 변경될 수 있는 마스터 맵이라고도 합니다. 마스터 맵은 시스템의 autofs- controlled 마운트 지점과 자동 마운트 맵이라는 해당 구성 파일 또는 네트워크 소스를 나열합니다. 마스터 맵 형식은 다음과 같습니다.

mount-point map-name options

- mount-point

- autofs 마운트 지점(예:

/home)입니다. - map-name

- 마운트 지점 목록이 포함된 맵 소스의 이름과 해당 마운트 지점을 마운트해야 하는 파일 시스템 위치입니다.

- options

- 제공된 경우 지정된 맵의 모든 항목에 적용되지만 자체적으로 옵션이 지정되지 않습니다. 이 동작은 옵션이 누적된 autofs 버전 4와 다릅니다. 이는 혼합된 환경 호환성을 구현하도록 변경되었습니다.

예 8.3. /etc/auto.master File

/etc/auto.master 파일의 샘플 행입니다( cat /etc/auto.master와 함께 표시됨).

/home /etc/auto.misc

mount-point [options] location

- mount-point

- 이는 autofs 마운트 지점을 나타냅니다. 간접 마운트를 위한 단일 디렉터리 이름 또는 직접 마운트를 위한 마운트 지점의 전체 경로일 수 있습니다. 각 직접 및 간접 맵 항목 키(마운트 지점) 뒤에는 여러 마운트 항목으로 알려진 오프셋 디렉토리(각 디렉터리 이름)가

/로 시작하는 오프셋 디렉토리 목록이 올 수 있습니다. - options

- 제공할 때마다 자체 옵션을 지정하지 않는 맵 항목의 마운트 옵션입니다.

- 위치

- 이는 로컬 파일 시스템 경로( Sun map format escape 문자 ":"로 시작하는 맵 이름), NFS 파일 시스템 또는 기타 유효한 파일 시스템 위치와 같은 파일 시스템 위치를 나타냅니다.

/etc/auto.misc).

payroll -fstype=nfs personnel:/dev/hda3 sales -fstype=ext3 :/dev/hda4

직원이라는 서버의 판매 /home/payroll 및 / home/ale 입니다. -fstype= 옵션은 종종 생략되며, 일반적으로 올바른 작업에 필요하지 않습니다.

# systemctl start autofs# systemctl restart autofs/home/ payroll/2006/July.sxc 와 같은 autofs 마운트 해제된 디렉토리에 액세스해야 하는 경우 자동 마운트 데몬에서 자동으로 디렉터리를 마운트합니다. 시간 초과를 지정하면 시간 제한 기간 동안 디렉터리에 액세스하지 않으면 디렉터리가 자동으로 마운트 해제됩니다.

# systemctl status autofs8.3.3. 사이트 구성 파일 덮어쓰기 또는 수정

- 자동 마운터 맵은 NIS에 저장되고

/etc/nsswitch.conf파일에는 다음 지시문이 있습니다.automount: files nis

auto.master파일에는 다음이 포함됩니다.+auto.master

- NIS

auto.master맵 파일에는 다음이 포함됩니다./home auto.home

- NIS

auto.home맵에는 다음이 포함됩니다.beth fileserver.example.com:/export/home/beth joe fileserver.example.com:/export/home/joe * fileserver.example.com:/export/home/&

- 파일 맵

/etc/auto.home이 없습니다.

auto.home 을 재정의하고 다른 서버의 홈 디렉터리를 마운트해야 한다고 가정하겠습니다. 이 경우 클라이언트는 다음 /etc/auto.master 맵을 사용해야 합니다.

/home /etc/auto.home +auto.master

/etc/auto.home 맵에는 항목이 포함되어 있습니다.

* labserver.example.com:/export/home/&

/home 에는 NIS auto.home 맵 대신 /etc/auto.home 내용이 포함됩니다.

auto.home 맵을 보강하려면 /etc/auto.home 파일 맵을 만들고 새 항목이 배치됩니다. 끝에 NIS auto.home 맵을 포함합니다. 그런 다음 /etc/auto.home 파일 맵은 다음과 유사합니다.

mydir someserver:/export/mydir +auto.home

auto.home 맵 조건을 사용하면 ls /home 명령이 출력됩니다.

beth joe mydir

8.3.4. LDAP를 사용하여 자동 마운터 맵 저장

openldap 패키지는 Manila의 종속성으로 자동 설치되어야 합니다. LDAP 액세스를 구성하려면 /etc/openldap/ldap.conf 를 수정합니다. BASE, URI 및 스키마가 사이트에 적절히 설정되어 있는지 확인합니다.

rfc2307bis 에 설명되어 있습니다. 이 스키마를 사용하려면 스키마 정의에서 주석 문자를 제거하여 autofs 구성(/etc/sysconfig/autofs)에서 설정해야 합니다. 예를 들어 다음과 같습니다.

예 8.4. autofs 설정

DEFAULT_MAP_OBJECT_CLASS="automountMap" DEFAULT_ENTRY_OBJECT_CLASS="automount" DEFAULT_MAP_ATTRIBUTE="automountMapName" DEFAULT_ENTRY_ATTRIBUTE="automountKey" DEFAULT_VALUE_ATTRIBUTE="automountInformation"

rfc2307bis 스키마의 cn 속성을 대체합니다. 다음은 LDAP 데이터 상호 변경 형식(LDIF) 구성의 예입니다.

예 8.5. LDF 설정

# extended LDIF # # LDAPv3 # base <> with scope subtree # filter: (&(objectclass=automountMap)(automountMapName=auto.master)) # requesting: ALL # # auto.master, example.com dn: automountMapName=auto.master,dc=example,dc=com objectClass: top objectClass: automountMap automountMapName: auto.master # extended LDIF # # LDAPv3 # base <automountMapName=auto.master,dc=example,dc=com> with scope subtree # filter: (objectclass=automount) # requesting: ALL # # /home, auto.master, example.com dn: automountMapName=auto.master,dc=example,dc=com objectClass: automount cn: /home automountKey: /home automountInformation: auto.home # extended LDIF # # LDAPv3 # base <> with scope subtree # filter: (&(objectclass=automountMap)(automountMapName=auto.home)) # requesting: ALL # # auto.home, example.com dn: automountMapName=auto.home,dc=example,dc=com objectClass: automountMap automountMapName: auto.home # extended LDIF # # LDAPv3 # base <automountMapName=auto.home,dc=example,dc=com> with scope subtree # filter: (objectclass=automount) # requesting: ALL # # foo, auto.home, example.com dn: automountKey=foo,automountMapName=auto.home,dc=example,dc=com objectClass: automount automountKey: foo automountInformation: filer.example.com:/export/foo # /, auto.home, example.com dn: automountKey=/,automountMapName=auto.home,dc=example,dc=com objectClass: automount automountKey: / automountInformation: filer.example.com:/export/&

8.4. 일반적인 NFS 마운트 옵션

/etc/fstab 설정 및 autofs 와 함께 사용할 수 있습니다.

- lookupcache=mode

- 커널이 지정된 마운트 지점의 디렉터리 항목 캐시를 관리하는 방법을 지정합니다. mode 에 유효한 인수는

all,none또는pos/positive입니다. - nfsvers=version

- 사용할 NFS 프로토콜의 버전을 지정합니다. 여기서 version 은 3 또는 4입니다. 이 기능은 여러 NFS 서버를 실행하는 호스트에 유용합니다. 버전을 지정하지 않으면 NFS는 kernel에서 지원하는 가장 높은 버전과 mount 명령을 사용합니다.옵션 vers 는 nfsvers 와 동일하며 호환성을 이유로 이 릴리스에 포함됩니다.

- noacl

- ACL 처리를 모두 해제합니다. 최신 ACL 기술이 이전 시스템과 호환되지 않기 때문에 이전 버전의 Red Hat Enterprise Linux, Red Hat Linux 또는 Solaris와 상호 작용해야 할 수 있습니다.

- NOLOCK

- 파일 잠금을 비활성화합니다. 이 설정은 매우 오래된 NFS 서버에 연결할 때 필요한 경우가 있습니다.

- noexec

- 마운트된 파일 시스템에서 바이너리 실행을 방지합니다. 이는 시스템이 호환되지 않는 바이너리가 포함된 비 Linux 파일 시스템을 마운트하는 경우에 유용합니다.

- nosuid

set-user-identifier또는set-group-identifier비트를 비활성화합니다. 이렇게 하면 원격 사용자가 setuid 프로그램을 실행하여 더 높은 권한을 얻지 못합니다.- port=num

- NFS 서버 포트의 숫자 값을 지정합니다. num 이 0 (기본값)이면 사용할 포트 번호에 대해 원격 호스트의 CHAP bind 서비스를 쿼리합니다. 원격 호스트의 NFS 데몬이 changed bind 서비스에 등록되지 않은 경우 표준 NFS 포트 번호 TCP 2049가 대신 사용됩니다.

- rsize=num 및 wsize=num

- 이러한 옵션은 단일 NFS 읽기 또는 쓰기 작업에서 전송할 최대 바이트 수를 설정합니다.

rsize및wsize에 대한 고정 기본값은 없습니다. 기본적으로 NFS는 서버와 클라이언트 모두 지원하는 가장 큰 값을 사용합니다. Red Hat Enterprise Linux 7에서 클라이언트 및 서버 최대값은 1,048,576 바이트입니다. 자세한 내용은 NFS 마운트를 사용한 rsize 및 wsize의 기본값과 최대값을 참조하십시오. Kbase 문서. - sec=flavors

- 마운트된 내보내기의 파일에 액세스하는 데 사용할 보안 플레이버입니다. flavor 값은 하나 이상의 보안 플레이버 로 구성된 콜론으로 구분된 목록입니다.기본적으로 클라이언트는 클라이언트와 서버 지원 보안 플레이버를 찾습니다. 서버가 선택한 플레이버를 지원하지 않으면 마운트 작업이 실패합니다.

sec=sys는 로컬 UNIX UID와 GID를 사용합니다. 이러한 작업은AUTH_SYS를 사용하여 NFS 작업을 인증합니다.sec=krb5는 로컬 UNIX UID 및 GID 대신 Kerberos V5를 사용하여 사용자를 인증합니다.sec=krb5i는 사용자 인증에 Kerberos V5를 사용하고 데이터 변조를 방지하기 위해 보안 체크섬을 사용하여 NFS 작업을 무결성 검사를 수행합니다.sec=krb5p는 사용자 인증, 무결성 검사 및 NFS 트래픽을 암호화하여 트래픽 스니핑을 방지하기 위해 Kerberos V5를 사용합니다. 이는 가장 안전한 설정이지만 성능 오버헤드가 가장 많습니다. - tcp

- NFS 마운트에 TCP 프로토콜을 사용하도록 지시합니다.

- udp

- NFS 마운트에 UDP 프로토콜을 사용하도록 지시합니다.

8.5. NFS 서버 시작 및 중지

사전 요구 사항

- NFSv2 또는 NFSv3 연결을 지원하는 서버의 경우 INPUT

bind[1]서비스가 실행 중이어야 합니다.rpcbind가 활성 상태인지 확인하려면 다음 명령을 사용합니다.$systemctl status rpcbindNFSv4 전용 서버를 구성하는 데 필요한 NFSv4 전용 서버를 구성하려면 8.6.7절. “NFSv4 전용 서버 구성” 을 참조하십시오. - Red Hat Enterprise Linux 7.0에서 NFS 서버가 NFSv3를 내보내고 부팅 시 시작되도록 활성화된 경우

nfs-lock서비스를 수동으로 시작하고 활성화해야 합니다.#systemctl start nfs-lock#systemctl enable nfs-lockRed Hat Enterprise Linux 7.1 이상에서는 필요한 경우nfs-lock이 자동으로 시작되고 수동으로 활성화하려고 합니다.

절차

- NFS 서버를 시작하려면 다음 명령을 사용하십시오.

# systemctl start nfs - 부팅 시 시작되도록 NFS를 활성화하려면 다음 명령을 사용합니다.

# systemctl enable nfs - 서버를 중지하려면 다음을 사용합니다.

# systemctl stop nfs 다시 시작옵션은 NFS를 중지한 다음 시작할 수 있는 간단한 방법입니다. 이 방법은 NFS 구성 파일을 편집한 후 구성 변경을 적용하는 가장 효율적인 방법입니다. 서버 유형을 다시 시작하려면 다음을 수행합니다.# systemctl restart nfs/etc/sysconfig/nfs파일을 편집한 후 새 값이 적용되도록 다음 명령을 실행하여 nfs-config 서비스를 다시 시작합니다.# systemctl restart nfs-configtry-restart명령은 현재 실행 중인 경우에만 nfs 를 시작합니다. 이 명령은 Red Hat init 스크립트의 condrestart( 조건부 재시작 )와 동일하며 NFS가 실행되고 있지 않은 경우 데몬을 시작하지 않기 때문에 유용합니다.서버를 조건부로 다시 시작하려면 다음을 입력합니다.# systemctl try-restart nfs- 서비스 유형을 다시 시작하지 않고 NFS 서버 구성 파일을 다시 로드하려면 다음을 수행합니다.

# systemctl reload nfs

8.6. NFS 서버 구성

- NFS 구성 파일 즉,

/etc/exports를 수동으로 편집할 수 있습니다. - 명령행을 통해, 즉 exportfs명령을 사용하여

8.6.1. /etc/exports 구성 파일

/etc/exports 파일은 원격 호스트로 내보낼 파일 시스템을 제어하고 옵션을 지정합니다. 다음 구문 규칙을 따릅니다.

- 빈 줄은 무시됩니다.

- 주석을 추가하려면 해시 표시(#)로 행을 시작합니다.

- 긴 줄을 백슬래시(\)로 래핑할 수 있습니다.

- 내보낸 각 파일 시스템은 고유한 개별 행에 있어야 합니다.

- 내보낸 파일 시스템 뒤에 배치된 권한 있는 호스트 목록은 공백 문자로 구분해야 합니다.

- 각 호스트에 대한 옵션은 호스트와 첫 번째 괄호를 구분하여 호스트 식별자 뒤에 직접 배치해야 합니다.

export host(options)

- export

- 내보낼 디렉토리

- host

- 내보내기를 공유할 호스트 또는 네트워크

- options

- 호스트에사용할 옵션

export host1(options1) host2(options2) host3(options3)

/etc/exports 파일은 내보낸 디렉토리와 다음 예와 같이 액세스하도록 허용된 호스트만 지정합니다.

예 8.6. /etc/exports 파일

/exported/directory bob.example.com

bob.example.com 는 NFS 서버에서 /exported/directory/ 를 마운트할 수 있습니다. 이 예에서는 옵션이 지정되지 않으므로 NFS는 기본 설정을 사용합니다.

- ro

- 내보낸 파일 시스템은 읽기 전용입니다. 원격 호스트는 파일 시스템에서 공유하는 데이터를 변경할 수 없습니다. 호스트가 파일 시스템(즉, 읽기 및 쓰기)을 변경할 수 있도록 허용하려면

rw옵션을 지정합니다. - sync

- 이전 요청의 변경 전에 NFS 서버는 요청에 응답하지 않습니다. 대신 비동기 쓰기를 활성화하려면

async옵션을 지정합니다. - wdelay

- 다른 쓰기 요청이 무미한 것으로 의심되는 경우 NFS 서버는 디스크에 쓰기를 지연합니다. 이렇게 하면 별도의 쓰기 명령으로 디스크에 액세스해야 하는 횟수가 줄어들어 쓰기 오버헤드가 줄어들어 성능을 향상시킬 수 있습니다. 이를 비활성화하려면

no_wdelay를 지정합니다.no_wdelay는 기본동기화옵션도 지정된 경우에만 사용할 수 있습니다. - root_squash

- 이렇게 하면 루트 사용자가 root 권한을 원격으로 연결할 수 없습니다. 대신, NFS 서버에서 사용자 ID

nfsnobody를 할당합니다. 이를 통해 원격 루트 사용자의 권한을 가장 낮은 로컬 사용자에게 효과적으로 "스쿼리"하여 원격 서버에 무단 쓰기를 방지할 수 있습니다. 루트 스쿼시를 비활성화하려면no_root_squash를 지정합니다.

all_squash 를 사용합니다. NFS 서버가 특정 호스트의 원격 사용자에게 할당해야 하는 사용자 및 그룹 ID를 지정하려면 다음과 같이 anonuid 및 anongid 옵션을 각각 사용합니다.

export host(anonuid=uid,anongid=gid)

anonuid 및 anongid 옵션을 사용하면 원격 NFS 사용자가 공유할 수 있는 특수 사용자 및 그룹 계정을 만들 수 있습니다.

rw 옵션을 지정하지 않으면 내보낸 파일 시스템이 읽기 전용으로 공유됩니다. 다음은 두 가지 기본 옵션을 재정의하는 /etc/exports 의 샘플 행입니다.

/another/exported/directory/ 읽기 및 쓰기를 마운트할 수 있으며 디스크에 대한 모든 쓰기는 비동기입니다. 옵션 내보내기에 대한 자세한 내용은 man exportfs 를 참조하십시오.

/etc/exports 파일의 형식은 특히 공백 문자를 사용하는 것과 관련하여 매우 정확합니다. 내보낸 파일 시스템을 항상 공백 문자를 사용하여 호스트 및 호스트와 서로 분리해야 합니다. 주석 행을 제외하고 파일에는 다른 공백 문자가 없어야 합니다.

/home bob.example.com(rw) /home bob.example.com (rw)

bob.example.com 의 사용자만 /home 디렉터리에 대한 읽기 및 쓰기 액세스 권한을 허용합니다. 두 번째 행을 사용하면 bob.example.com 의 사용자가 디렉터리를 읽기 전용(기본값)으로 마운트할 수 있으며 나머지 사용자는 읽기/쓰기로 마운트할 수 있습니다.

8.6.2. exportfs 명령

/etc/exports 파일에 나열됩니다. nfs 서비스가 시작되면 /usr/sbin/exportfs 명령이 이 파일을 시작하고 읽고 이 파일을 읽고, 실제 마운트 프로세스의 경우 CHAP .mountd (if NFSv3)에 제어를 전달한 다음, 원격 사용자가 파일 시스템을 사용할 수 있는 locations .nfsd 에 대한 제어를 전달합니다.

/var/lib/nfs/xtab 에 씁니다. file 시스템에 대한 액세스 권한을 결정할 때 xtab.mountd 는 xtab 파일을 참조하므로 내보낸 파일 시스템 목록의 변경 사항이 즉시 적용됩니다.

- -r

/var/lib/nfs/etab에 새 내보내기 목록을 구성하여/etc/exports에 나열된 모든 디렉토리를 내보내도록 합니다. 이 옵션은/etc/exports를 변경하여 내보내기 목록을 효과적으로 새로 고칩니다.- -a

- /usr/sbin/exportfs 에 전달되는 다른 옵션에 따라 모든 디렉토리를 내보내거나 내보내기 해제하도록 합니다. 다른 옵션이 지정되지 않은 경우 /usr/sbin/exportfs 는

/etc/exports에 지정된 모든 파일 시스템을 내보냅니다. - -o file-systems

/etc/exports에 나열되지 않은 내보낼 디렉토리를 지정합니다. 파일 시스템을 내보낼 추가 파일 시스템으로 교체합니다. 이러한 파일 시스템은/etc/exports에 지정된 방식과 동일하게 포맷해야 합니다. 이 옵션은 내보낼 파일 시스템 목록에 영구적으로 추가하기 전에 내보낸 파일 시스템을 테스트하는 데 자주 사용됩니다./etc/exports구문에 대한 자세한 내용은 8.6.1절. “/etc/exports구성 파일” 을 참조하십시오.- -i

/etc/exports는 무시합니다. 명령줄에 제공된 옵션만 내보낸 파일 시스템을 정의하는 데 사용됩니다.- -u

- 모든 공유 디렉토리를 연결을 해제합니다. /usr/sbin/exportfs -ua 명령은 모든 NFS 데몬을 유지하면서 NFS 파일 공유를 일시 중지합니다. NFS 공유를 다시 활성화하려면 exportfs -r 을 사용합니다.

- -v

- exportfs 명령을 실행할 때 내보내거나 내보내지 않은 파일 시스템이 더 자세히 표시되는 상세 작업입니다.

8.6.2.1. NFSv4에서 exportfs 사용

/etc/sysconfig/nfs 에서 RPCNFSDARGS= -N 4 를 설정하여 전원을 끕니다.

8.6.3. NFS 실행 방화벽

/etc/sysconfig/nfs 파일을 편집하여 RPC 서비스가 실행되는 포트를 설정합니다. 방화벽을 통해 클라이언트가 RPC 할당량에 액세스할 수 있도록 허용하려면 8.6.4절. “방화벽을 통해 RPC 할당량에 액세스” 을 참조하십시오.

/etc/sysconfig/nfs 파일은 기본적으로 모든 시스템에 존재하지 않습니다. /etc/sysconfig/nfs 가 없는 경우 이를 생성하고 다음을 지정합니다.

- RPCMOUNTDOPTS="-p port"

- 이를 통해 "-p 포트"-p 포트 ".pc.mount 명령 행:authorization .mount -p 포트 가 추가됩니다.

nlockmgr 서비스에서 사용할 포트를 지정하려면 /etc/modprobe.d/lockd.conf 파일의 nlm_tcpport 및 nlm_udpport 옵션에 대한 포트 번호를 설정합니다.

/var/log/messages 를 확인합니다. 일반적으로 이미 사용 중인 포트 번호를 지정하면 NFS가 시작되지 않습니다. /etc/sysconfig/nfs 를 편집한 후 새 값이 Red Hat Enterprise Linux 7.2 및 실행 전에 적용되도록 nfs-config 서비스를 다시 시작해야 합니다.

# systemctl restart nfs-config

그런 다음 NFS 서버를 다시 시작하십시오.

# systemctl restart nfs-server

alice info -p 를 실행하여 변경 사항이 적용되었는지 확인합니다.

/proc/sys/fs/nfs_callback_tcpport 를 설정하고 서버가 클라이언트의 해당 포트에 연결할 수 있습니다.

mountd,statd, lockd 를 위한 다른 포트는 순수 NFSv4 환경에 필요하지 않습니다.

8.6.3.1. NFS 내보내기 검색

- NFSv3를 지원하는 모든 서버에서 showmount 명령을 사용합니다.

$showmount -e myserver Export list for mysever /exports/foo /exports/bar - NFSv4를 지원하는 모든 서버에서 루트 디렉터리를 마운트하고 살펴봅니다.

#mount myserver:/ /mnt/#cd /mnt/ exports#ls exports foo bar

8.6.4. 방화벽을 통해 RPC 할당량에 액세스

절차 8.1. RPC 할당량 액세스 가능으로 방화벽 설정

- EgressIP

-rquotad 서비스를활성화하려면 다음 명령을 사용합니다.#systemctl enable rpc-rquotad - EgressIP

-rquotad서비스를 시작하려면 다음 명령을 사용합니다.

g#systemctl start rpc-rquotadRPC-rquotad는 활성화된 경우nfs-server서비스를 시작한 후 자동으로 시작됩니다. - 방화벽 뒤에서 할당량 RPC 서비스에 액세스할 수 있도록 하려면 UDP 또는 TCP 포트

875를 열어야 합니다. 기본 포트 번호는/etc/services파일에 정의됩니다./etc/sysconfig/rpc를 추가하여 기본 포트 번호를 덮어쓸 수 있습니다.-rquotad파일의RPCRQUOTADOPTS변수에 -p port-number /etc/sysconfig/파일의 변경 사항을 적용하려면 INPUT-rquotad를 다시 시작하십시오.rpc-rquotad#systemctl restart rpc-rquotad

원격 호스트에서 할당량 설정

/etc/sysconfig/rpc-rquotad 파일의 RPCRQUOTADOPTS 변수에 -S 옵션을 추가합니다.

/etc/sysconfig/ rpc-rquotad 파일의 변경 사항을 적용하려면 INPUT-rquotad를 다시 시작하십시오.

# systemctl restart rpc-rquotad

8.6.5. 호스트 이름 형식

- 단일 머신

- 정규화된 도메인 이름(서버로 해결할 수 있음), 호스트 이름(서버로 확인할 수 있음) 또는 IP 주소입니다.

- 와일드카드로 지정된 일련의 머신

*또는?문자를 사용하여 일치하는 문자열을 지정합니다. IP 주소와 함께 와일드카드를 사용할 수 없지만 역방향 DNS 조회가 실패하는 경우 실수로 작동하지 않을 수 있습니다. 정규화된 도메인 이름에 와일드 카드를 지정할 때 점(.)은 와일드카드에 포함되지 않습니다. 예를 들어*.example.com에는one.example.com이 포함되지만include one.two.example.com은 포함되지 않습니다.- IP 네트워크

- a.b.c.d/z 를 사용합니다. 여기서 a.b.c.d 는 네트워크이며 z 는 넷마스크의 비트 수입니다(예:httpd). 또 다른 허용 가능한 형식은 a.b.c.d입니다. 여기서 a.b.c.d 는 네트워크 및 넷마스크 입니다(예: 192.168.100.8/255.255.0).

- netgroups

- @group-name 포맷을 사용합니다. 여기서 group-name 은 NIS netgroup 이름입니다.

8.6.6. RDMA(NFSORDMA)를 통한 NFS 활성화

- rdma 및 rdma-core 패키지를 설치합니다.

/etc/rdma/rdma.conf파일에는 기본적으로XPRTRDMA_LOAD=yes를 설정하는 행이 포함되어 있으며, 이 행은rdma서비스가 NFSoRDMA 클라이언트 모듈을 로드하도록 요청합니다. - NFSoRDMA 서버 모듈의 자동 로드를 활성화하려면

/etc/rdma/rdma.conf의 새 줄에SVCRDMA_LOAD=yes을 추가합니다.RPCNFSDARGS="--rdma=20049"/etc/sysconfig/nfs파일에서 NFSoRDMA 서비스가 클라이언트를 수신 대기하는 포트 번호를 지정합니다. RFC 5667 은 RDMA를 통해 NFSv4 서비스를 제공할 때 서버가 포트20049에서 수신 대기해야 함을 지정합니다. /etc/rdma/rdma.conf파일을 편집한 후nfs서비스를 다시 시작하십시오.#systemctl restart nfs이전 커널 버전에서는 변경 사항이 적용되려면/etc/rdma/rdma.conf를 편집한 후 시스템 재부팅이 필요합니다.

8.6.7. NFSv4 전용 서버 구성

수 와 시스템에서 서비스를 실행하면 됩니다.

Requested NFS version or transport protocol is not supported.

절차 8.2. NFSv4 전용 서버 구성

/etc/sysconfig/nfs구성 파일에 다음 행을 추가하여 NFSv2, NFSv3 및 UDP를 비활성화합니다.RPCNFSDARGS="-N 2 -N 3 -U"

- 필요한 경우 NFSv4 전용 경우 필요하지 않은

RPCBIND,MOUNT,NSM프로토콜 호출에 대한 수신 대기를 비활성화합니다.이러한 옵션을 비활성화하는 방법은 다음과 같습니다.- NFSv2 또는 NFSv3를 사용하여 서버의 공유를 마운트하려고 시도하는 클라이언트가 응답하지 않습니다.

- NFS 서버 자체는 NFSv2 및 NFSv3 파일 시스템을 마운트할 수 없습니다.

이러한 옵션을 비활성화하려면 다음을 수행합니다.- 다음을

/etc/sysconfig/nfs파일에 추가합니다.RPCMOUNTDOPTS="-N 2 -N 3"

- 관련 서비스를 비활성화합니다.

#systemctl mask --now rpc-statd.service rpcbind.service rpcbind.socket

- NFS 서버를 다시 시작합니다.

#systemctl restart nfs변경 사항은 NFS 서버를 시작하거나 다시 시작하는 즉시 적용됩니다.

8.6.7.1. NFSv4 전용 설정 확인

netstat 유틸리티를 사용하여 NFS 서버가 NFSv4 전용 모드로 구성되었는지 확인할 수 있습니다.

- 다음은 NFSv4 전용 서버의

netstat출력 예입니다.RPCBIND,MOUNT및NSM수신 대기도 비활성화됩니다.nfs는 유일한 수신 대기 NFS 서비스입니다.#netstat -ltu Active Internet connections (only servers) Proto Recv-Q Send-Q Local Address Foreign Address State tcp 0 0 0.0.0.0:nfs 0.0.0.0:* LISTEN tcp 0 0 0.0.0.0:ssh 0.0.0.0:* LISTEN tcp 0 0 localhost:smtp 0.0.0.0:* LISTEN tcp6 0 0 [::]:nfs [::]:* LISTEN tcp6 0 0 [::]:12432 [::]:* LISTEN tcp6 0 0 [::]:12434 [::]:* LISTEN tcp6 0 0 localhost:7092 [::]:* LISTEN tcp6 0 0 [::]:ssh [::]:* LISTEN udp 0 0 localhost:323 0.0.0.0:* udp 0 0 0.0.0.0:bootpc 0.0.0.0:* udp6 0 0 localhost:323 [::]:* - 반면 NFSv4 전용 서버를 구성하기 전에

netstat출력에는sunrpc및mountd서비스가 포함되어 있습니다.#netstat -ltu Active Internet connections (only servers) Proto Recv-Q Send-Q Local Address Foreign Address State tcp 0 0 0.0.0.0:nfs 0.0.0.0:* LISTEN tcp 0 0 0.0.0.0:36069 0.0.0.0:* LISTEN tcp 0 0 0.0.0.0:52364 0.0.0.0:* LISTEN tcp 0 0 0.0.0.0:sunrpc 0.0.0.0:* LISTEN tcp 0 0 0.0.0.0:mountd 0.0.0.0:* LISTEN tcp 0 0 0.0.0.0:ssh 0.0.0.0:* LISTEN tcp 0 0 localhost:smtp 0.0.0.0:* LISTEN tcp6 0 0 [::]:34941 [::]:* LISTEN tcp6 0 0 [::]:nfs [::]:* LISTEN tcp6 0 0 [::]:sunrpc [::]:* LISTEN tcp6 0 0 [::]:mountd [::]:* LISTEN tcp6 0 0 [::]:12432 [::]:* LISTEN tcp6 0 0 [::]:56881 [::]:* LISTEN tcp6 0 0 [::]:12434 [::]:* LISTEN tcp6 0 0 localhost:7092 [::]:* LISTEN tcp6 0 0 [::]:ssh [::]:* LISTEN udp 0 0 localhost:323 0.0.0.0:* udp 0 0 0.0.0.0:37190 0.0.0.0:* udp 0 0 0.0.0.0:876 0.0.0.0:* udp 0 0 localhost:877 0.0.0.0:* udp 0 0 0.0.0.0:mountd 0.0.0.0:* udp 0 0 0.0.0.0:38588 0.0.0.0:* udp 0 0 0.0.0.0:nfs 0.0.0.0:* udp 0 0 0.0.0.0:bootpc 0.0.0.0:* udp 0 0 0.0.0.0:sunrpc 0.0.0.0:* udp6 0 0 localhost:323 [::]:* udp6 0 0 [::]:57683 [::]:* udp6 0 0 [::]:876 [::]:* udp6 0 0 [::]:mountd [::]:* udp6 0 0 [::]:40874 [::]:* udp6 0 0 [::]:nfs [::]:* udp6 0 0 [::]:sunrpc [::]:*

8.7. NFS 보안

8.7.1. AUTH_SYS 및 Export Controls를 사용한 NFS 보안

AUTH_SYS ( AUTH_UNIX라고도 함)를 사용합니다. 즉, 악성 또는 잘못 구성된 클라이언트가 쉽게이 잘못된 얻을 수 있으며 사용자가 사용하지 않아야하는 파일에 대한 액세스를 허용 할 수 있습니다.

8.7.2. AUTH_GSS를 사용한 NFS 보안

Kerberos 구성

절차 8.3. RPCSEC_GSS를 사용하도록 IdM용 NFS 서버 및 클라이언트 구성

- NFS 서버 측에서

nfs/hostname.domain@REALM주체를 생성합니다. - server 및 client side 둘 다에

host/hostname.domain@REALM주체를 생성합니다. - 클라이언트 및 서버의 키탭에 해당 키를 추가합니다.

자세한 내용은 Red Hat Enterprise Linux 7 Linux 도메인 ID, 인증 및 정책 가이드 의 Kerberos 인식 NFS 서버 섹션 추가 및 편집 서비스 항목을 참조하십시오.- 서버 측에서

sec=옵션을 사용하여 원하는 보안 플레이버를 활성화합니다. 모든 보안 플레이버 및 비 암호화 마운트를 활성화하려면 다음을 수행합니다./export *(sec=sys:krb5:krb5i:krb5p)

sec=옵션과 함께 사용할 유효한 보안 플레이버는 다음과 같습니다.sys: 암호화 보호 없음, 기본값krb5: 인증 전용krb5i: 무결성 보호krb5p: 개인 정보 보호

- 클라이언트 측에서 마운트 옵션에

sec=krb5(또는sec=krb5i,sec=krb5p, sec=krb5p )를 추가합니다.# mount -o sec=krb5 server:/export /mnt

NFS 클라이언트를 구성하는 방법에 대한 자세한 내용은 Red Hat Enterprise Linux 7 Linux 도메인 ID, 인증 및 정책 가이드의 Kerberos 인식 NFS 클라이언트 설정 섹션을 참조하십시오.

추가 리소스

- Red Hat은 IdM 사용을 권장하지만 AD(Active Directory) Kerberos 서버도 지원됩니다. 자세한 내용은 SSSD 및 Active Directory를 사용하여 RHEL 7에서 Kerberos 인증을 사용하여 NFS를 설정하는 방법을 참조하십시오.

- Kerberos 보안 NFS 공유에 root로 파일을 쓰고 이러한 파일에 대해 루트 소유권을 유지해야 하는 경우 의 내용을 참조하십시오 https://access.redhat.com/articles/4040141. 이 구성은 권장되지 않습니다.

8.7.2.1. NFSv4를 통한 NFS 보안

MOUNT 프로토콜 사용을 제거하는 것입니다. MOUNT 프로토콜은 프로토콜에서 파일을 처리하는 방식 때문에 보안 위험이 발생했습니다.

8.7.3. 파일 권한

nobody 로 설정됩니다. root squashing은 기본 옵션 root_squash 에 의해 제어됩니다. 이 옵션에 대한 자세한 내용은 8.6.1절. “/etc/exports 구성 파일” 을 참조하십시오. 가능한 경우 루트 스쿼시를 비활성화하지 마십시오.

all_squash 옵션을 사용하는 것이 좋습니다. 이 옵션을 사용하면 내보낸 파일 시스템에 액세스하는 모든 사용자가 nfsnobody 사용자의 사용자 ID를 가져옵니다.

8.8. NFS 및 authorizationbind

bind 서비스가 필요한 NFSv3 구현에만 적용됩니다.

bind 가 필요하지 않은 NFSv4 전용 서버를 구성하는 방법에 대한 자세한 내용은 8.6.7절. “NFSv4 전용 서버 구성” 을 참조하십시오.

8.8.1. NFS 및authorization bind 문제해결

# rpcinfo -p예 8.7. Diffieinfo -p 명령 출력

program vers proto port service

100021 1 udp 32774 nlockmgr

100021 3 udp 32774 nlockmgr

100021 4 udp 32774 nlockmgr

100021 1 tcp 34437 nlockmgr

100021 3 tcp 34437 nlockmgr

100021 4 tcp 34437 nlockmgr

100011 1 udp 819 rquotad

100011 2 udp 819 rquotad

100011 1 tcp 822 rquotad

100011 2 tcp 822 rquotad

100003 2 udp 2049 nfs

100003 3 udp 2049 nfs

100003 2 tcp 2049 nfs

100003 3 tcp 2049 nfs

100005 1 udp 836 mountd

100005 1 tcp 839 mountd

100005 2 udp 836 mountd

100005 2 tcp 839 mountd

100005 3 udp 836 mountd

100005 3 tcp 839 mountd8.9. pNFS

pNFS Flex Files

PNFS 공유 마운트

- pNFS 기능을 활성화하려면 NFS 버전 4.1 이상에서 pNFS 사용 서버의 공유를 마운트합니다.

#mount -t nfs -o v4.1 server:/remote-export /local-directory서버가 pNFS를 사용하면 첫 번째 마운트에nfs_layout_nfsv41_files커널이 자동으로 로드됩니다. 출력의 mount 항목에minorversion=1이 포함되어야 합니다. 다음 명령을 사용하여 모듈이 로드되었는지 확인합니다.$ lsmod | grep nfs_layout_nfsv41_files - flex Files를 지원하는 서버의 flex Files 기능으로 NFS 공유를 마운트하려면 NFS 버전 4.2 이상을 사용합니다.

#mount -t nfs -o v4.2 server:/remote-export /local-directorynfs_layout_flexfiles모듈이 로드되었는지 확인합니다.$lsmod | grep nfs_layout_flexfiles

추가 리소스

8.10. NFS에서 pNFS SCSI 레이아웃 활성화

사전 요구 사항

- 클라이언트와 서버 모두 동일한 블록 장치에 SCSI 명령을 보낼 수 있어야 합니다. 즉, 블록 장치는 공유 SCSI 버스에 있어야 합니다.

- 블록 장치에는 XFS 파일 시스템이 포함되어야 합니다.

- SCSI 장치는 SCSI-3 기본 명령 사양에 설명된 대로 SCSI 영구 예약을 지원해야 합니다.

8.10.1. pNFS SCSI 레이아웃

클라이언트와 서버 간 작업

LAYOUTGET 작업을 수행합니다. 서버는 SCSI 장치에 있는 파일의 위치로 응답합니다. 클라이언트는 GETDEVICEINFO 의 추가 작업을 수행하여 사용할 SCSI 장치를 결정해야 할 수 있습니다. 이러한 작업이 올바르게 작동하는 경우 클라이언트는 READ 및 WRITE 작업을 서버로 보내는 대신 I/O 요청을 SCSI 장치로 직접 실행할 수 있습니다.

READ 및 WRITE 작업을 서버에 실행하기 위해 대체됩니다.

장치 예약

8.10.2. pNFS에서 SCSI 장치 호환성 확인

사전 요구 사항

- sg3_utils 패키지를 설치합니다.

# yum install sg3_utils

절차 8.4. pNFS에서 SCSI 장치 호환성 확인

- 서버와 클라이언트 모두에서 적절한 SCSI 장치 지원이 있는지 확인합니다.

# sg_persist --in --report-capabilities --verbose path-to-scsi-device

Persist through Power losts Active(PTPL_A) 비트가 설정되었는지 확인합니다.예 8.8. pNFS SCSI를 지원하는 SCSI 장치

다음은 pNFS SCSI를 지원하는 SCSI 장치의sg_persist출력 예입니다. POSTPL_A비트는1을 보고합니다.inquiry cdb: 12 00 00 00 24 00 Persistent Reservation In cmd: 5e 02 00 00 00 00 00 20 00 00 LIO-ORG block11 4.0 Peripheral device type: disk Report capabilities response: Compatible Reservation Handling(CRH): 1 Specify Initiator Ports Capable(SIP_C): 1 All Target Ports Capable(ATP_C): 1 Persist Through Power Loss Capable(PTPL_C): 1 Type Mask Valid(TMV): 1 Allow Commands: 1 Persist Through Power Loss Active(PTPL_A): 1 Support indicated in Type mask: Write Exclusive, all registrants: 1 Exclusive Access, registrants only: 1 Write Exclusive, registrants only: 1 Exclusive Access: 1 Write Exclusive: 1 Exclusive Access, all registrants: 1

추가 리소스

- sg_persist(8) 도움말 페이지

8.10.3. 서버에서 pNFS SCSI 설정

절차 8.5. 서버에서 pNFS SCSI 설정

- 서버에서 SCSI 장치에 생성된 XFS 파일 시스템을 마운트합니다.

- NFS 버전 4.1 이상을 내보내도록 NFS 서버를 구성합니다.

/etc/nfs.conf파일의[nfsd]섹션에서 다음 옵션을 설정합니다.[nfsd] vers4.1=y

pnfs옵션을 사용하여 NFS를 통해 XFS 파일 시스템을 내보내도록 NFS 서버를 구성합니다.예 8.9. pNFS SCSI 내보내기의 /etc/exports의 항목

/etc/exports구성 파일의 다음 항목은/exported/directory/에 마운트된 파일 시스템을 pNFS SCSI 레이아웃으로allowed.example.com클라이언트에 내보냅니다./exported/directory allowed.example.com(pnfs)

추가 리소스

- NFS 서버 구성에 대한 자세한 내용은 8.6절. “NFS 서버 구성” 을 참조하십시오.

8.10.4. 클라이언트에서 pNFS SCSI 설정

사전 요구 사항

- NFS 서버는 pNFS SCSI를 통해 XFS 파일 시스템을 내보내도록 구성됩니다. 8.10.3절. “서버에서 pNFS SCSI 설정” 을 참조하십시오.

절차 8.6. 클라이언트에서 pNFS SCSI 설정

- 클라이언트에서 NFS 버전 4.1 이상을 사용하여 내보낸 XFS 파일 시스템을 마운트합니다.

# mount -t nfs -o nfsvers=4.1 host:/remote/export /local/directory

NFS 없이 직접 XFS 파일 시스템을 마운트하지 마십시오.

추가 리소스

- NFS 공유 마운트에 대한 자세한 내용은 8.2절. “NFS 클라이언트 구성” 을 참조하십시오.

8.10.5. 서버에서 pNFS SCSI 예약 해제

사전 요구 사항

- sg3_utils 패키지를 설치합니다.

# yum install sg3_utils

절차 8.7. 서버에서 pNFS SCSI 예약 해제

- 서버에서 기존 예약을 쿼리합니다.

# sg_persist --read-reservation path-to-scsi-device

예 8.10. /dev/sda에서 예약 쿼리

# sg_persist --read-reservation /dev/sda LIO-ORG block_1 4.0 Peripheral device type: disk PR generation=0x8, Reservation follows: Key=0x100000000000000 scope: LU_SCOPE, type: Exclusive Access, registrants only - 서버에서 기존 등록을 제거합니다.

# sg_persist --out \ --release \ --param-rk=reservation-key \ --prout-type=6 \ path-to-scsi-device예 8.11. /dev/sda에 예약 삭제

# sg_persist --out \ --release \ --param-rk=0x100000000000000 \ --prout-type=6 \ /dev/sda LIO-ORG block_1 4.0 Peripheral device type: disk

추가 리소스

- sg_persist(8) 도움말 페이지

8.10.6. pNFS SCSI 레이아웃 기능 모니터링

사전 요구 사항

- pNFS SCSI 클라이언트와 서버가 구성되어 있습니다.

8.10.6.1. nfsstat를 사용하여 서버에서 pNFS SCSI 작업 확인

nfsstat 유틸리티를 사용하여 서버에서 pNFS SCSI 작업을 모니터링합니다.

절차 8.8. nfsstat를 사용하여 서버에서 pNFS SCSI 작업 확인

- 서버에서 서비스되는 작업을 모니터링합니다.

# watch --differences \ "nfsstat --server | egrep --after-context=1 read\|write\|layout" Every 2.0s: nfsstat --server | egrep --after-context=1 read\|write\|layout putrootfh read readdir readlink remove rename 2 0% 0 0% 1 0% 0 0% 0 0% 0 0% -- setcltidconf verify write rellockowner bc_ctl bind_conn 0 0% 0 0% 0 0% 0 0% 0 0% 0 0% -- getdevlist layoutcommit layoutget layoutreturn secinfononam sequence 0 0% 29 1% 49 1% 5 0% 0 0% 2435 86% - 다음과 같은 경우 클라이언트 및 서버는 pNFS SCSI 작업을 사용합니다.

레이아웃get,layoutreturn,layoutcommit카운터 증가 즉, 서버가 레이아웃을 제공하고 있습니다.- 서버

읽기및쓰기카운터는 증가하지 않습니다. 즉 클라이언트가 SCSI 장치에 직접 I/O 요청을 수행하고 있습니다.

8.10.6.2. mountstats를 사용하여 클라이언트에서 pNFS SCSI 작업 확인

/proc/self/mountstats 파일을 사용하여 클라이언트에서 pNFS SCSI 작업을 모니터링합니다.

절차 8.9. mountstats를 사용하여 클라이언트에서 pNFS SCSI 작업 확인

- 마운트당 작업 카운터를 나열합니다.

# cat /proc/self/mountstats \ | awk /scsi_lun_0/,/^$/ \ | egrep device\|READ\|WRITE\|LAYOUT device 192.168.122.73:/exports/scsi_lun_0 mounted on /mnt/rhel7/scsi_lun_0 with fstype nfs4 statvers=1.1 nfsv4: bm0=0xfdffbfff,bm1=0x40f9be3e,bm2=0x803,acl=0x3,sessions,pnfs=LAYOUT_SCSI READ: 0 0 0 0 0 0 0 0 WRITE: 0 0 0 0 0 0 0 0 READLINK: 0 0 0 0 0 0 0 0 READDIR: 0 0 0 0 0 0 0 0 LAYOUTGET: 49 49 0 11172 9604 2 19448 19454 LAYOUTCOMMIT: 28 28 0 7776 4808 0 24719 24722 LAYOUTRETURN: 0 0 0 0 0 0 0 0 LAYOUTSTATS: 0 0 0 0 0 0 0 0 - 결과에서 다음을 수행합니다.

LAYOUT통계는 클라이언트와 서버가 pNFS SCSI 작업을 사용하는 요청을 나타냅니다.READ및WRITE통계는 클라이언트와 서버가 NFS 작업으로 대체되는 요청을 나타냅니다.

8.11. NFS 참조

8.11.1. 설치된 문서

- man mount - NFS 서버 및 클라이언트 구성을 위한 마운트 옵션을 포괄적으로 포함합니다.

- man fstab - 부팅 시 파일 시스템을 마운트하는 데 사용되는

/etc/fstab파일 형식에 대한 세부 정보를 제공합니다. - man nfs - NFS 관련 파일 시스템 내보내기 및 마운트 옵션에 대한 세부 정보를 제공합니다.

- man export - NFS 파일 시스템을 내보낼 때

/etc/exports파일에 사용되는 일반적인 옵션을 표시합니다.

8.11.2. 유용한 웹 사이트

- http://linux-nfs.org - 프로젝트 상태 업데이트를 볼 수 있는 개발자의 현재 사이트입니다.

- http://nfs.sourceforge.net/ - 여전히 유용한 정보가 많이 들어 있는 개발자의 오래된 홈입니다.

- http://www.citi.umich.edu/projects/nfsv4/linux/ - Linux 2.6 커널 리소스의 NFSv4

- http://citeseer.ist.psu.edu/viewdoc/summary?doi=10.1.1.111.4086 - NFS 버전 4 프로토콜의 기능 및 개선 사항에 대한 우수한 백서입니다.

8.11.3. 관련 도서

- Hal Stern, Mike Eisler, Ricardo Labiaga에 의해 NFS 및 NIS를 관리합니다. O'Reilly & Associates; O'Reilly & Associates - 사용 가능한 다양한 NFS 내보내기 및 마운트 옵션에 대한 유용한 참조 가이드를 제공합니다.

- NFS Illustrated by Brent Callaghan; Addison-Wesley Publishing Company - NFS의 다른 네트워크 파일 시스템과의 비교 기능을 제공하고 NFS 통신이 발생하는 방식을 자세히 보여줍니다.

9장. 서버 메시지 블록(SMB)

cifs-utils 유틸리티를 사용하여 원격 서버에서 SMB 공유를 마운트합니다.

cifs 라는 이름을 사용합니다.

9.1. SMB 공유 제공

9.2. SMB 공유 마운트

cifs.ko 파일 시스템 모듈은 SMB 프로토콜을 지원합니다. 그러나 SMB 공유 영역을 마운트하고 사용하려면 cifs-utils 패키지도 설치해야 합니다.

# yum install cifs-utils- SMB 및 CIFS 공유 마운트

- 커널 인증 키에서 NTLM( NT Lan Manager) 인증 정보 관리

- SMB 및 CIFS 공유의 보안 설명자에 ACL(액세스 제어 목록) 설정 및 표시

9.2.1. 지원되는 SMB 프로토콜 버전

cifs.ko 커널 모듈은 다음 SMB 프로토콜 버전을 지원합니다.

- SMB 1

- SMB 2.0

- SMB 2.1

- SMB 3.0

9.2.1.1. UNIX 확장 지원

CAP_UNIX 기능 비트를 사용하여 UNIX 확장 기능을 제공합니다. 이러한 확장 기능은 cifs.ko 커널 모듈에서도 지원됩니다. 그러나 Samba와 kernel 모듈은 모두 SMB 1 프로토콜에서만 UNIX 확장을 지원합니다.

/etc/samba/smb.conf파일의[global]섹션에서server min protocol옵션을NT1로 설정합니다. 이는 Samba 서버에서 기본적으로 설정됩니다.- mount 명령에

-o vers=1.0옵션을 제공하여 SMB 1 프로토콜을 사용하여 공유를 마운트합니다. 예를 들어 다음과 같습니다.mount -t cifs -o vers=1.0,username=user_name //server_name/share_name /mnt/기본적으로 kernel 모듈은 서버에서 지원하는 SMB 2 이상 프로토콜 버전을 사용합니다. mount 명령에-o vers=1.0옵션을 전달하면 커널 모듈이 UNIX 확장 기능을 사용하는 데 필요한 SMB 1 프로토콜을 사용하도록 강제 적용합니다.

# mount

...

//server/share on /mnt type cifs (...,unix,...)

9.2.2. SMB 공유 수동 마운트

-t cifs 매개변수와 함께 mount 유틸리티를 사용합니다.

# mount -t cifs -o username=user_name //server_name/share_name /mnt/ Password for user_name@//server_name/share_name: ********

-o options 매개변수에서는 공유를 마운트하는 데 사용할 옵션을 지정할 수 있습니다. 자세한 내용은 mount.cifs(8) 도움말 페이지의 9.2.6절. “자주 사용되는 마운트 옵션” 및 OPTIONS 섹션을 참조하십시오.

예 9.1. 암호화된 SMB 3.0 연결을 사용하여 공유 마운트

\\server\example\ example \ example \ 는 암호화된 SMB 3.0 연결을 통해 /mnt/ 디렉토리에 DOMAIN\Administrator 사용자로 마운트하려면 다음을 수행합니다.

# mount -t cifs -o username=DOMAIN\Administrator,seal,vers=3.0 //server/example /mnt/ Password for user_name@//server_name/share_name: ********

9.2.3. 시스템 부팅 시 SMB 공유 자동 마운트

/etc/fstab 파일에 공유에 대한 항목을 추가합니다. 예를 들어 다음과 같습니다.

//server_name/share_name /mnt cifs credentials=/root/smb.cred 0 0

/etc/fstab 파일의 네 번째 필드에서 자격 증명 파일의 경로와 같은 마운트 옵션을 지정합니다. 자세한 내용은 mount.cifs(8) 도움말 페이지의 9.2.6절. “자주 사용되는 마운트 옵션” 및 OPTIONS 섹션을 참조하십시오.

# mount /mnt/9.2.4. 인증 정보 파일을 사용하여 SMB 공유로 인증

절차 9.1. 인증 정보 파일 생성

~/datasources.cred와 같은 파일을 생성하고 사용자 이름, 암호 및 해당 파일에 도메인 이름을 지정합니다.username=user_name password=password domain=domain_name

- 소유자만 파일에 액세스할 수 있도록 권한을 설정합니다.

#chown user_name ~/smb.cred#chmod 600 ~/smb.cred

credentials=file_name 마운트 옵션을 마운트 유틸리티에 전달하거나 /etc/fstab 파일에서 사용자 이름과 암호를 입력하라는 메시지가 표시되지 않고 공유를 마운트할 수 있습니다.

9.2.5. 다중 사용자 SMB 마운트 수행

DOMAIN\example 사용자를 사용하는 경우 작업을 수행하는 로컬 사용자와 관계없이 공유의 모든 작업이 이 사용자로 실행됩니다.

다중 사용자 마운트 옵션을 사용하면 이 시나리오를 구성할 수 있습니다.

다중 사용자를 사용하려면 sec=security_type 마운트 옵션을 krb5 와 같은 비대화형 방식으로 또는 자격 증명 파일과 함께 ntlmssp 옵션과 같은 비대화형 방식으로 제공하는 보안 유형으로 추가로 설정해야 합니다. “사용자로 공유를 액세스” 을 참조하십시오.

root 사용자는 다중 사용자 옵션과 공유 콘텐츠에 대한 최소 액세스 권한이 있는 계정을 사용하여 공유를 마운트합니다. 그런 다음 일반 사용자는 rfc 유틸리티를 사용하여 현재 세션의 커널 인증 키에 사용자 이름과 암호를 제공할 수 있습니다. 9.2.5.1. 다중 사용자 옵션을 사용하여 공유 마운트

다중 사용자 옵션을 사용하여 공유를 자동으로 마운트하려면 다음을 수행합니다.

절차 9.2. 다중 사용자 옵션을 사용하여 /etc/fstab 파일 항목 생성

/etc/fstab파일에서 공유에 대한 항목을 만듭니다. 예를 들어 다음과 같습니다.//server_name/share_name /mnt cifs multiuser,sec=ntlmssp,credentials=/root/smb.cred 0 0- 공유를 마운트합니다.

#mount /mnt/

-o multiuser,sec=security_type 를 전달하여 수동으로 마운트합니다. SMB 공유 마운트에 대한 자세한 내용은 9.2.2절. “SMB 공유 수동 마운트” 을 참조하십시오.

9.2.5.2. 다중 사용자 옵션을 사용하여 SMB 공유가 마운트되었는지 확인

다중 사용자 옵션을 사용하여 공유가 마운트되었는지 확인하려면 다음을 수행하십시오.

# mount

...

//server_name/share_name on /mnt type cifs (sec=ntlmssp,multiuser,...)

9.2.5.3. 사용자로 공유를 액세스

# cifscreds add -u SMB_user_name server_name

Password: ********

9.2.6. 자주 사용되는 마운트 옵션

- 서버와의 연결을 설정하는 방법 예를 들어 서버에 연결할 때 사용되는 SMB 프로토콜 버전은 무엇입니까.

- 공유가 로컬 파일 시스템에 마운트되는 방법. 예를 들어 시스템이 원격 파일 및 디렉터리 권한을 재정의하여 여러 로컬 사용자가 서버의 콘텐츠에 액세스할 수 있도록 합니다.

/etc/fstab 파일의 네 번째 필드 또는 마운트 명령의 -o 매개 변수에 여러 옵션을 설정하려면 쉼표로 구분합니다. 예를 들어 절차 9.2. “다중 사용자 옵션을 사용하여 /etc/fstab 파일 항목 생성” 의 내용을 참조하십시오.

표 9.1. 자주 사용되는 마운트 옵션

| 옵션 | 설명 |

|---|---|

| credentials=file_name | 자격 증명 파일의 경로를 설정합니다. 9.2.4절. “인증 정보 파일을 사용하여 SMB 공유로 인증” 을 참조하십시오. |

| dir_mode=mode | 서버가 CIFS UNIX 확장을 지원하지 않는 경우 디렉터리 모드를 설정합니다. |

| file_mode=mode | 서버가 CIFS UNIX 확장을 지원하지 않는 경우 파일 모드를 설정합니다. |

| password=password | SMB 서버에 인증하는 데 사용되는 암호를 설정합니다. 또는 credentials 옵션을 사용하여 자격 증명 파일을 지정합니다. |