Red Hat Training

A Red Hat training course is available for Red Hat Enterprise Linux

논리 볼륨 관리자 관리

Red Hat Enterprise Linux 7

LVM 논리 볼륨 구성 및 관리

초록

이 문서에서는 클러스터형 환경에서 LVM 실행 정보를 포함하여 LVM 논리 볼륨 관리자를 설명합니다.

1장. LVM 논리 볼륨 관리자

이 장에서는 Red Hat Enterprise Linux 7의 초기 릴리스 이후 새로운 LVM 논리 볼륨 관리자의 기능에 대해 설명합니다. 이 장에서는 LVM(Logical Volume Manager)의 구성 요소에 대한 간략한 개요도 제공합니다.

1.1. 새로운 기능 및 변경된 기능

이 섹션에는 Red Hat Enterprise Linux 7의 초기 릴리스 이후 새로운 LVM 논리 볼륨 관리자의 기능이 나열됩니다.

1.1.1. Red Hat Enterprise Linux 7.1의 새로운 기능 및 변경된 기능

Red Hat Enterprise Linux 7.1에는 다음 문서 및 기능 업데이트 및 변경 사항이 포함되어 있습니다.

- 씬 프로비저닝된 볼륨 및 씬 프로비저닝된 스냅샷에 대한 문서가 명확히 되어 있습니다. LVM 씬 프로비저닝에 대한 추가 정보는 이제 lvmthin(7) 도움말 페이지에 있습니다. 씬 프로비저닝된 논리 볼륨에 대한 일반적인 정보는 2.3.4절. “씬 프로비저닝된 논리 볼륨(Thin Volumes)” 을 참조하십시오. 씬 프로비저닝된 스냅샷 볼륨에 대한 자세한 내용은 2.3.6절. “씬 프로비저닝된 스냅샷 볼륨” 을 참조하십시오.

- 이 설명서는 이제 B.2절. “lvmconfig 명령” 에 lvm dumpconfig 명령을 문서화합니다. Red Hat Enterprise Linux 7.2 릴리스에서는 이 명령의 이름이 lvmconfig 로 변경되었지만 이전 형식은 계속 작동합니다.

- 이 설명서는 B.3절. “LVM 프로필” 에 LVM 프로필을 문서화합니다.

- 이 설명서는 이제 3.6절. “lvm 명령을 사용하여 LVM 정보 표시” 에 lvm 명령을 문서화합니다.

- Red Hat Enterprise Linux 7.1 릴리스에서는 4.4.20절. “논리 볼륨 활성화 제어” 에 설명된 대로 lvcreate 및 lvchange 명령의 -k 및 -K 옵션을 사용하여 씬 풀 스냅샷 활성화를 제어할 수 있습니다.

- 이 매뉴얼은 Cryostat import 명령의

--force인수를 문서화합니다. 이를 통해 누락된 물리 볼륨인 볼륨 그룹을 가져오고 나중에 Cryostatreduce --removemissing 명령을 실행할 수 있습니다. Cryostat import 명령에 대한 자세한 내용은 4.3.15절. “다른 시스템으로 볼륨 그룹 이동” 을 참조하십시오. - 이 매뉴얼은 Cryostatreduce 명령의

--mirrorsonly인수 를 문서화합니다. 이를 통해 실패한 물리 볼륨에서 미러 이미지인 논리 볼륨만 제거할 수 있습니다. 이 옵션 사용에 대한 자세한 내용은 4.3.15절. “다른 시스템으로 볼륨 그룹 이동” 을 참조하십시오.

또한 문서를 통해 소규모 기술 수정 및 설명이 수행되었습니다.

1.1.2. Red Hat Enterprise Linux 7.2의 새로운 기능 및 변경된 기능

Red Hat Enterprise Linux 7.2에는 다음 문서 및 기능 업데이트 및 변경 사항이 포함되어 있습니다.

- 많은 LVM 처리 명령에서

-S또는--select옵션을 사용하여 해당 명령에 대한 선택 기준을 정의합니다. LVM 선택 기준이 새 부록 부록 C. LVM 선택 기준 에 설명되어 있습니다. - 이 문서에서는 4.4.8절. “LVM 캐시 논리 볼륨 생성” 에서 캐시 논리 볼륨을 생성하기 위한 기본 절차를 설명합니다.

- 이 문서의 문제 해결 장에는 6.7절. “다중 경로 장치에 대한 PV 경고 중복” 새 섹션이 포함되어 있습니다.

- Red Hat Enterprise Linux 7.2 릴리스에서는 이전 형식이 계속 작동하지만 lvm dumpconfig 명령의 이름이 lvmconfig 로 변경되었습니다. 이러한 변경 사항은 이 문서 전체에 반영됩니다.

또한 문서를 통해 소규모 기술 수정 및 설명이 수행되었습니다.

1.1.3. Red Hat Enterprise Linux 7.3의 새로운 기능 및 변경된 기능

Red Hat Enterprise Linux 7.3에는 다음 문서 및 기능 업데이트 및 변경 사항이 포함되어 있습니다.

- LVM은 RAID0 세그먼트 유형을 지원합니다. RAID0은 스트라이프 크기 단위로 여러 데이터 하위 볼륨에 논리 볼륨 데이터를 분산합니다. RAID0 볼륨 생성에 대한 자세한 내용은 4.4.3.1절. “RAID0 볼륨 생성(Red Hat Enterprise Linux 7.3 및 later)” 을 참조하십시오.

- lvm fullreport 명령을 사용하여 물리 볼륨, 볼륨 그룹, 논리 볼륨 세그먼트, 물리 볼륨 세그먼트 및 논리 볼륨 세그먼트에 대한 정보를 한 번에 보고할 수 있습니다. 이 명령 및 해당 기능에 대한 자세한 내용은 lvm-fullreport(8) 도움말 페이지를 참조하십시오.

- LVM은 LVM 명령 실행 중에 수집된 전체 오브젝트 식별을 통해 작업 로그, 메시지 및 개체별 상태를 포함하는 로그 보고서를 지원합니다. LVM 로그 보고서의 예는 4.8.6절. “명령 로그 보고(Red Hat Enterprise Linux 7.3 이상)” 를 참조하십시오. LVM 로그 보고서에 대한 자세한 내용은 lvmreport(7) 도움말 페이지를 참조하십시오.

- LVM 표시 명령의

--reportformat옵션을 사용하여 JSON 형식으로 출력을 표시할 수 있습니다. JSON 형식으로 표시된 출력 예는 4.8.5절. “JSON 형식 출력(Red Hat Enterprise Linux 7.3 이상)” 를 참조하십시오. - 이제

lvm.conf구성 파일에서record_lvs_history메타데이터 옵션을 활성화하여 제거된 thin snapshot 및 thin 논리 볼륨을 추적하도록 시스템을 구성할 수 있습니다. 이를 통해 원래 종속성 체인에서 제거되어 과거 논리 볼륨이 된 논리 볼륨이 포함된 전체 씬 스냅샷 종속성 체인을 표시할 수 있습니다. 기록 논리 볼륨에 대한 자세한 내용은 4.4.21절. “추적 및 표시 논리 볼륨 (Red Hat Enterprise Linux 7.3 및 later)” 을 참조하십시오.

또한 문서를 통해 소규모 기술 수정 및 설명이 수행되었습니다.

1.1.4. Red Hat Enterprise Linux 7.4의 새로운 기능 및 변경된 기능

Red Hat Enterprise Linux 7.4에는 다음 문서 및 기능 업데이트 및 변경 사항이 포함되어 있습니다.

- Red Hat Enterprise Linux 7.4는 RAID 인수 및 RAID 회전을 지원합니다. 이러한 기능에 대한 요약은 4.4.3.12절. “RAID takeover(Red Hat Enterprise Linux 7.4 및 later)” 및 4.4.3.13절. “RAID 논리 볼륨 조정(Red Hat Enterprise Linux 7.4 및 later)” 을 참조하십시오.

1.2. 논리 볼륨

볼륨 관리는 물리 스토리지에 대한 추상화 계층을 생성하여 논리 스토리지 볼륨을 생성할 수 있습니다. 이를 통해 물리적 스토리지를 직접 사용하는 것보다 여러 가지 면에서 유연성이 훨씬 향상됩니다. 논리 볼륨의 경우 물리 디스크 크기로 제한되지 않습니다. 또한 하드웨어 스토리지 구성은 소프트웨어에서 숨겨져 있으므로 애플리케이션을 중지하거나 파일 시스템을 마운트 해제하지 않고도 크기를 조정하고 이동할 수 있습니다. 이는 운영 비용을 줄일 수 있습니다.

논리 볼륨은 물리적 스토리지를 직접 사용하는 것보다 다음과 같은 이점을 제공합니다.

- 유연한 용량논리 볼륨을 사용하는 경우 디스크와 파티션을 단일 논리 볼륨으로 집계할 수 있으므로 파일 시스템은 여러 디스크에 걸쳐 확장될 수 있습니다.

- 크기 조정 가능한 스토리지 풀기본 디스크 장치를 다시 포맷하고 다시 파티션하지 않고도 논리 볼륨을 확장하거나 간단한 소프트웨어 명령으로 크기를 줄일 수 있습니다.

- 온라인 데이터 재배치최신의, 속도 또는 더 유연한 스토리지 하위 시스템을 배포하기 위해 시스템을 활성화하는 동안 데이터를 이동할 수 있습니다. 디스크가 사용 중인 상태에서 데이터를 다시 정렬할 수 있습니다. 예를 들어 제거하기 전에 hot-swappable 디스크를 비워 둘 수 있습니다.

- 편리한 장치 이름 지정논리 스토리지 볼륨은 사용자 정의 및 사용자 지정 명명된 그룹에서 관리할 수 있습니다.

- 디스크 스트라이핑두 개 이상의 디스크에 데이터를 스트라이프하는 논리 볼륨을 만들 수 있습니다. 이는 처리량을 크게 높일 수 있습니다.

- 볼륨 미러링논리 볼륨은 데이터의 미러를 구성하는 편리한 방법을 제공합니다.

- 볼륨 스냅샷논리 볼륨을 사용하면 일관된 백업에 대해 장치 스냅샷을 사용하거나 실제 데이터에 영향을 주지 않고 변경 효과를 테스트할 수 있습니다.

LVM에서 이러한 기능의 구현은 이 문서의 나머지 부분에서 설명합니다.

1.3. LVM 아키텍처 개요

참고

LVM2는 스냅샷 및 클러스터 지원을 제외하고 LVM1과 이전 버전과 호환됩니다. Cryostatconvert 명령을 사용하여 볼륨 그룹을 LVM1 형식에서 LVM2 형식으로 변환할 수 있습니다. LVM 메타데이터 형식을 변환하는 방법에 대한 자세한 내용은 Cryostat convert(8) 도움말 페이지를 참조하십시오.

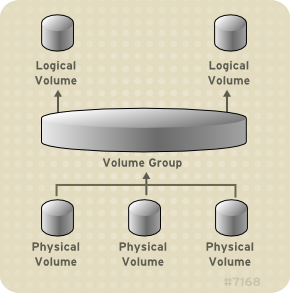

LVM 논리 볼륨의 기본 물리 저장 단위는 파티션 또는 전체 디스크와 같은 블록 장치입니다. 이 장치는 LVM 물리 볼륨 (PV)으로 초기화됩니다.

LVM 논리 볼륨을 만들기 위해 물리 볼륨은 볼륨 그룹 (VG)으로 결합됩니다. 이렇게 하면 LVM 논리 볼륨(LV)을 할당할 수 있는 디스크 공간 풀이 생성됩니다. 이 프로세스는 디스크를 파티션으로 분할하는 방식과 유사합니다. 논리 볼륨은 파일 시스템 및 애플리케이션(예: 데이터베이스)에서 사용합니다.

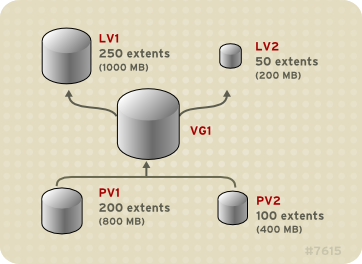

그림 1.1. “LVM 논리 볼륨 구성 요소” 는 간단한 LVM 논리 볼륨의 구성 요소를 표시합니다.

그림 1.1. LVM 논리 볼륨 구성 요소

[D]

LVM 논리 볼륨의 구성 요소에 대한 자세한 내용은 2장. LVM 구성 요소 을 참조하십시오.

1.4. Red Hat High Availability Cluster의 LVM 논리 볼륨

Red Hat High Availability Add-On에서는 두 가지 고유한 클러스터 구성에서 LVM 볼륨을 지원합니다.

- 클러스터의 단일 노드만 한 번에 스토리지에 액세스하는 활성/수동 장애 조치 구성의 HA-LVM(고가용성 LVM 볼륨)입니다.

- 클러스터의 두 개 이상의 노드가 동시에 스토리지에 액세스해야 하는 활성/활성 구성에서 클러스터형 논리 볼륨(CLVM) 확장을 사용하는 LVM 볼륨. CLVM은 스토리지 장애 복구 애드온의 일부입니다.

1.4.1. CLVM 또는 HA-LVM 선택

CLVM 또는 HA-LVM을 사용하는 경우 배포 중인 애플리케이션 또는 서비스 요구 사항을 기반으로 해야 합니다.

- 클러스터의 여러 노드에 활성/활성 시스템에서 LVM 볼륨에 대한 동시 읽기/쓰기 액세스 권한이 필요한 경우 CLVMD를 사용해야 합니다. CLVMD는 클러스터의 노드 간에 LVM 볼륨의 활성화 및 변경 사항을 조정하고 변경할 수 있는 시스템을 제공합니다. CLVMD 클러스터형 잠금 서비스는 클러스터의 다양한 노드와 볼륨과 상호 작용하고 레이아웃을 변경할 때 LVM 메타데이터를 보호합니다. 이러한 보호는

lvm.conf파일에서locking_type을 3으로 설정하고 CLVMD에서 관리하고 여러 클러스터 노드에서 동시에 활성화할 모든 볼륨 그룹에 클러스터형 플래그를 설정하는 등 해당 볼륨 그룹을 적절하게 구성할 때 발생합니다. - 고가용성 클러스터가 한 번에 지정된 LVM 볼륨에 대한 액세스 권한이 하나만 있는 활성/수동 방식으로 공유 리소스를 관리하도록 구성된 경우 CLVMD 클러스터형 잠금 서비스 없이 HA-LVM을 사용할 수 있습니다.

대부분의 애플리케이션은 다른 인스턴스와 동시에 실행되도록 설계되거나 최적화되지 않으므로 활성/수동 구성에서 더 잘 실행됩니다. 클러스터형 논리 볼륨에서 클러스터가 인식되지 않는 애플리케이션을 실행하도록 선택하면 논리 볼륨이 미러링된 경우 성능이 저하될 수 있습니다. 이러한 인스턴스에 논리 볼륨 자체의 클러스터 통신 오버헤드가 있기 때문입니다. 클러스터 인식 애플리케이션은 클러스터 파일 시스템 및 클러스터 인식 논리 볼륨에서 도입한 성능 손실보다 성능이 향상될 수 있어야 합니다. 이는 일부 애플리케이션과 워크로드에서 다른 애플리케이션 및 워크로드보다 쉽게 수행할 수 있습니다. 클러스터의 요구사항이 무엇인지, 활성/활성 클러스터 최적화를 위한 추가 노력은 두 LVM 변형 중 하나를 선택하는 방법입니다. 대부분의 사용자는 HA-LVM을 사용하여 최상의 HA 결과를 얻을 수 있습니다.

HA-LVM 및 CLVM은 LVM 메타데이터와 해당 논리 볼륨이 손상되는 것을 방지하기 때문에 여러 시스템에서 중복을 변경할 수 있는 경우 발생할 수 있습니다. HA-LVM은 논리 볼륨을 독점적으로만 활성화할 수 있는 제한을 적용합니다. 즉, 한 번에 하나의 시스템에서만 활성화됩니다. 즉, 스토리지 드라이버의 로컬(클러스터되지 않음) 구현만 사용됩니다. 이러한 방식으로 클러스터 조정 오버헤드를 방지하면 성능이 향상됩니다. CLVM은 이러한 제한 사항을 적용하지 않으며 사용자는 클러스터의 모든 시스템에서 논리 볼륨을 자유롭게 활성화할 수 있습니다. 따라서 클러스터 인식 스토리지 드라이버를 강제로 사용하므로 클러스터 인식 파일 시스템 및 애플리케이션을 맨 위에 배치할 수 있습니다.

1.4.2. 클러스터에서 LVM 볼륨 구성

Red Hat Enterprise Linux 7에서 클러스터는 Pacemaker를 통해 관리됩니다. HA-LVM 및 CLVM 논리 볼륨 모두 Pacemaker 클러스터와 함께 지원되며 클러스터 리소스로 구성해야 합니다.

- Pacemaker 클러스터의 일부로 HA-LVM 볼륨을 구성하는 절차는 High Availability Add-On Administration 의 Red Hat High Availability Cluster의 Active/passive Apache HTTP Server 를 참조하십시오. 이 절차에는 다음 단계가 포함됩니다.

- LVM 논리 볼륨 구성

- 클러스터만 볼륨 그룹을 활성화할 수 있는지 확인

- LVM 볼륨을 클러스터 리소스로 구성

- 클러스터에서 CLVM 볼륨을 구성하는 절차는 Global File System 2 의 클러스터에서 GFS2 파일 시스템 구성을 참조하십시오.

2장. LVM 구성 요소

이 장에서는 LVM 논리 볼륨의 구성 요소에 대해 설명합니다.

2.1. 물리 볼륨

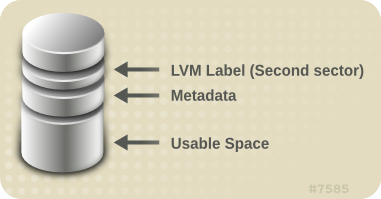

LVM 논리 볼륨의 기본 물리 저장 단위는 파티션 또는 전체 디스크와 같은 블록 장치입니다. LVM 논리 볼륨에 장치를 사용하려면 장치를 물리 볼륨(PV)으로 초기화해야 합니다. 블록 장치를 물리 볼륨으로 초기화하면 장치 시작 근처에 레이블이 배치됩니다.

기본적으로 LVM 레이블은 두 번째 512바이트 섹터에 배치됩니다. 물리 볼륨을 생성할 때 처음 4개 섹터에 라벨을 배치하여 이 기본값을 덮어쓸 수 있습니다. 이렇게 하면 필요한 경우 LVM 볼륨이 이러한 섹터의 다른 사용자와 공존할 수 있습니다.

LVM 레이블은 물리적 장치에 대해 올바른 식별 및 장치 순서를 제공합니다. 시스템이 부팅될 때 장치가 임의의 순서로 표시될 수 있기 때문입니다. LVM 레이블은 재부팅 및 클러스터 전체에서 유지됩니다.

LVM 레이블은 장치를 LVM 물리 볼륨으로 식별합니다. 물리 볼륨에 대한 임의의 고유 식별자( UUID)를 포함합니다. 또한 블록 장치의 크기(바이트)를 저장하고 LVM 메타데이터가 장치에 저장될 위치를 기록합니다.

LVM 메타데이터에는 시스템의 LVM 볼륨 그룹의 구성 세부 정보가 포함되어 있습니다. 기본적으로 메타데이터의 동일한 사본은 볼륨 그룹 내의 모든 물리 볼륨의 모든 메타데이터 영역에서 유지 관리됩니다. LVM 메타데이터는 크기가 작고 ASCII로 저장됩니다.

현재 LVM을 사용하면 각 물리 볼륨에서 0, 1 또는 2의 동일한 메타데이터 복사본을 저장할 수 있습니다. 기본값은 1 복사입니다. 물리 볼륨에 메타데이터 복사본 수를 구성하면 나중에 해당 번호를 변경할 수 없습니다. 첫 번째 사본은 라벨 직후에 장치 시작에 저장됩니다. 두 번째 복사본이 있으면 장치 끝에 배치됩니다. 의도와 다른 디스크에 작성하여 디스크의 시작 부분에 영역을 실수로 덮어 쓰기하면 장치 끝에 두 번째 메타데이터 복사본을 복구 할 수 있습니다.

LVM 메타데이터 및 메타데이터 매개변수 변경에 대한 자세한 내용은 부록 E. LVM 볼륨 그룹 메타데이터 을 참조하십시오.

2.1.1. LVM 물리 볼륨 레이아웃

그림 2.1. “물리 볼륨 레이아웃” LVM 물리 볼륨의 레이아웃을 표시합니다. LVM 레이블은 두 번째 섹터에 있으며, 메타데이터 영역 다음에 장치에서 사용 가능한 공간이 뒤에 있습니다.

참고

Linux 커널(및 이 문서 전체에서) 섹터는 크기가 512바이트인 것으로 간주됩니다.

그림 2.1. 물리 볼륨 레이아웃

[D]

2.1.2. 디스크의 여러 파티션

LVM을 사용하면 디스크 파티션에서 물리 볼륨을 만들 수 있습니다. 다음과 같은 이유로 LVM 물리 볼륨으로 레이블하기 위해 전체 디스크를 다루는 단일 파티션을 생성하는 것이 좋습니다.

- 관리 편의성각 실제 디스크가 한 번만 표시되는 경우 시스템에서 하드웨어를 추적하는 것이 더 쉽습니다. 디스크가 실패하면 특히 그렇습니다. 또한 단일 디스크의 여러 물리 볼륨이 부팅 시 알 수 없는 파티션 유형에 대한 커널 경고를 유발할 수 있습니다.

- 성능 제거LVM에서 두 개의 물리 볼륨이 동일한 물리 디스크에 있음을 확인할 수 없습니다. 두 개의 물리 볼륨이 동일한 물리 디스크에 있는 경우 스트라이프가 동일한 디스크의 다른 파티션에 있을 수 있습니다. 이로 인해 증가하지 않고 성능이 저하됩니다.

권장되지는 않지만 디스크를 별도의 LVM 물리 볼륨으로 분할해야 하는 경우 특정 상황이 있을 수 있습니다. 예를 들어 디스크가 거의 없는 시스템에서는 기존 시스템을 LVM 볼륨으로 마이그레이션할 때 파티션 주위에 데이터를 이동해야 할 수 있습니다. 또한 매우 큰 디스크가 있고 관리 목적으로 두 개 이상의 볼륨 그룹이 필요한 경우 디스크를 분할해야 합니다. 두 개 이상의 파티션이 있고 두 파티션 모두 동일한 볼륨 그룹에 있는 디스크가 있는 경우 스트립 볼륨을 생성할 때 논리 볼륨에 포함할 파티션을 지정합니다.

2.2. 볼륨 그룹

물리 볼륨은 볼륨 그룹(VG)으로 결합됩니다. 그러면 논리 볼륨을 할당할 수 있는 디스크 공간 풀이 생성됩니다.

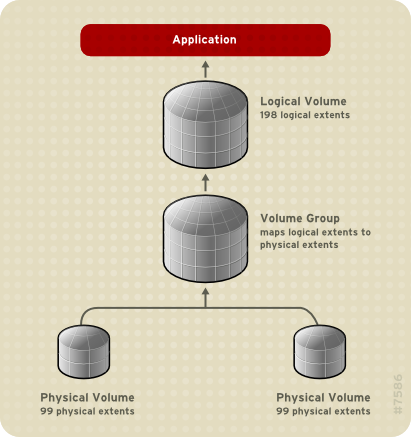

볼륨 그룹 내에서 할당에 사용 가능한 디스크 공간이 확장 영역이라는 고정 크기의 단위로 나뉩니다. 익스텐트는 할당할 수 있는 가장 작은 공간 단위입니다. 물리 볼륨 내에서 확장 영역을 물리 확장 영역으로 지정합니다.

논리 볼륨은 물리 확장 영역과 동일한 크기의 논리 확장 영역에 할당됩니다. 따라서 확장 크기는 볼륨 그룹의 모든 논리 볼륨에 대해 동일합니다. 볼륨 그룹은 논리 확장 영역을 물리 확장 영역에 매핑합니다.

2.3. LVM 논리 볼륨

LVM에서 볼륨 그룹은 논리 볼륨으로 나뉩니다. 다음 섹션에서는 다양한 유형의 논리 볼륨에 대해 설명합니다.

2.3.1. 선형 볼륨

선형 볼륨은 하나 이상의 물리 볼륨에서 하나의 논리 볼륨으로 공간을 집계합니다. 예를 들어, 두 개의 60GB 디스크가 있는 경우 120GB 논리 볼륨을 생성할 수 있습니다. 물리적 스토리지가 연결됩니다.

선형 볼륨을 만들면 물리 확장 영역의 범위를 순서대로 논리 볼륨 영역에 할당합니다. 예를 들어 그림 2.2. “범위 매핑” 논리 확장 영역 1에서 99에 표시된 것처럼 논리 확장 영역 100을 198에 매핑하면 두 번째 물리 볼륨에 매핑할 수 있습니다. 애플리케이션의 관점에서는 198개의 확장 영역 크기의 장치가 한 개 있습니다.

그림 2.2. 범위 매핑

[D]

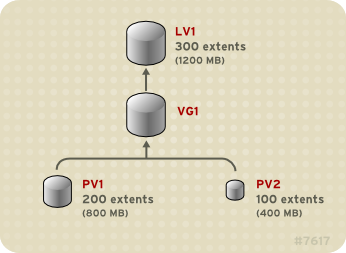

논리 볼륨을 구성하는 물리 볼륨은 크기가 같을 필요가 없습니다. 그림 2.3. “Unequal 물리 볼륨이 있는 선형 볼륨” 는 물리 확장 영역 크기가 4MB인

VG1 볼륨 그룹을 표시합니다. 이 볼륨 그룹에는 PV1 및 PV2 라는 두 개의 물리 볼륨이 포함되어 있습니다. 물리 볼륨은 확장 크기이므로 4MB 단위로 나뉩니다. 이 예에서 PV1 은 200개의 확장 영역 크기(800MB)이고 PV2 는 크기가 100개(400MB)입니다. 1에서 300개의 확장 영역(MB에서 1200MB) 사이의 모든 크기를 만들 수 있습니다. 이 예에서 LV1 이라는 선형 볼륨은 크기가 300개입니다.

그림 2.3. Unequal 물리 볼륨이 있는 선형 볼륨

[D]

물리 확장 영역 풀에서 필요한 크기에 대해 두 개 이상의 선형 논리 볼륨을 구성할 수 있습니다. 그림 2.4. “다중 논리 볼륨” 는 그림 2.3. “Unequal 물리 볼륨이 있는 선형 볼륨” 와 동일한 볼륨 그룹을 표시하지만, 이 경우 두 개의 논리 볼륨이 볼륨 그룹에서 분리되었습니다.

LV1 은 크기(1000MB) 및 LV2 의 크기(200MB) 및 50개의 확장 영역입니다.

그림 2.4. 다중 논리 볼륨

[D]

2.3.2. 제거된 논리 볼륨

LVM 논리 볼륨에 데이터를 쓸 때 파일 시스템은 기본 물리 볼륨에 걸쳐 데이터를 배치합니다. 스트라이핑된 논리 볼륨을 생성하여 데이터를 물리 볼륨에 쓰는 방식을 제어할 수 있습니다. 대규모 순차적 읽기 및 쓰기의 경우 데이터 I/O의 효율성을 향상시킬 수 있습니다.

스트리핑은 라운드 로빈 방식으로 미리 정해진 수의 물리 볼륨에 데이터를 작성하여 성능을 향상시킵니다. 스트라이핑을 통해 I/O를 병렬로 수행할 수 있습니다. 경우에 따라 스트라이프의 추가 물리 볼륨에 대해 거의 선형 성능이 저하될 수 있습니다.

다음 그림에서는 세 개의 물리 볼륨에 걸쳐 있는 데이터를 보여줍니다. 이 그림에서 다음을 수행합니다.

- 데이터의 첫 번째 스트라이프는 첫 번째 물리 볼륨에 기록됩니다.

- 데이터의 두 번째 스트라이프는 두 번째 물리 볼륨에 기록됩니다.

- 세 번째 데이터 스트라이프는 세 번째 물리 볼륨에 기록됩니다.

- 데이터의 네 번째 스트라이프는 첫 번째 물리 볼륨에 기록됩니다.

스트라이핑된 논리 볼륨에서 스트라이프 크기는 확장 영역 크기를 초과할 수 없습니다.

그림 2.5. 세 개의 PV 간 데이터 제거

[D]

줄인 논리 볼륨은 다른 장치 집합을 첫 번째 세트의 끝에 연결하여 확장할 수 있습니다. 그러나 스트라이핑된 논리 볼륨을 확장하려면 스트라이프를 지원하기 위해 기본 물리 볼륨 세트에 충분한 여유 공간이 있어야 합니다. 예를 들어 전체 볼륨 그룹을 사용하는 양방향 스트라이프가 있는 경우 볼륨 그룹에 단일 물리 볼륨을 추가하면 스트라이프를 확장할 수 없습니다. 대신 볼륨 그룹에 두 개 이상의 물리 볼륨을 추가해야 합니다. 스트라이핑된 볼륨 확장에 대한 자세한 내용은 4.4.17절. “스트립 볼륨 확장” 을 참조하십시오.

2.3.3. RAID 논리 볼륨

LVM은 RAID0/1/4/5/6/10을 지원합니다. LVM RAID 볼륨에는 다음과 같은 특징이 있습니다.

- LVM을 통해 생성 및 관리하는 RAID 논리 볼륨은 MD 커널 드라이버를 활용합니다.

- RAID1 이미지는 일시적으로 배열에서 분할하고 나중에 다시 배열로 병합할 수 있습니다.

- LVM RAID 볼륨은 스냅샷을 지원합니다.

RAID 논리 볼륨 생성에 대한 자세한 내용은 4.4.3절. “RAID 논리 볼륨” 을 참조하십시오.

참고

RAID 논리 볼륨은 클러스터가 인식되지 않습니다. RAID 논리 볼륨은 한 컴퓨터에서만 생성하고 활성화할 수 있지만 두 개 이상의 컴퓨터에서 동시에 활성화할 수 없습니다.

2.3.4. 씬 프로비저닝된 논리 볼륨(Thin Volumes)

논리 볼륨은 씬 프로비저닝할 수 있습니다. 이를 통해 사용 가능한 확장 영역보다 큰 논리 볼륨을 만들 수 있습니다. 씬 프로비저닝을 사용하면 씬 풀이라는 여유 공간 스토리지 풀을 관리할 수 있으며, 애플리케이션에 필요할 때 임의의 수의 장치에 할당할 수 있습니다. 그런 다음 애플리케이션이 논리 볼륨에 실제로 쓸 때 나중에 할당하기 위해 씬 풀에 바인딩될 수 있는 장치를 생성할 수 있습니다. 스토리지 공간을 비용 효율적으로 할당하는 데 필요할 때 씬 풀을 동적으로 확장할 수 있습니다.

참고

클러스터의 노드에서는 씬 볼륨이 지원되지 않습니다. thin 풀과 모든 씬 볼륨은 하나의 클러스터 노드에서만 독점적으로 활성화되어야 합니다.

스토리지 관리자는 씬 프로비저닝을 사용하여 물리적 스토리지를 과다 할당할 수 있으므로 추가 스토리지를 구매할 필요가 없는 경우가 많습니다. 예를 들어, 10명의 사용자가 애플리케이션에 대해 100GB 파일 시스템을 요청하는 경우 스토리지 관리자는 각 사용자에 대해 100GB 파일 시스템으로 표시되는 항목을 생성할 수 있지만 필요한 경우에만 사용되는 실제 스토리지에서는 지원되지 않습니다.

참고

씬 프로비저닝을 사용할 때는 스토리지 관리자가 스토리지 풀을 모니터링하고 용량을 늘리기 시작하는 것이 중요합니다.

사용 가능한 모든 공간을 사용할 수 있도록 LVM에서 데이터 삭제 기능을 지원합니다. 이를 통해 삭제한 파일 또는 다른 블록 범위에서 이전에 사용한 공간을 다시 사용할 수 있습니다.

씬 볼륨 생성에 대한 자세한 내용은 4.4.5절. “씬 프로비저닝된 논리 볼륨 생성” 에서 참조하십시오.

씬 볼륨은 여러 가상 장치가 씬 풀에서 동일한 데이터를 공유할 수 있도록 새로운 COW(Copy-On-Write) 스냅샷 논리 볼륨을 구현할 수 있도록 지원합니다. 씬 스냅샷 볼륨에 대한 자세한 내용은 2.3.6절. “씬 프로비저닝된 스냅샷 볼륨” 에서 참조하십시오.

2.3.5. 스냅샷 볼륨

LVM 스냅샷 기능을 사용하면 서비스 중단 없이 특정 즉시 장치의 가상 이미지를 생성할 수 있습니다. 스냅샷을 만든 후 원래 장치(원본)를 변경하면 스냅샷 기능을 통해 장치의 상태를 재구성할 수 있도록 변경 전과 마찬가지로 변경된 데이터 영역을 복사합니다.

참고

LVM은 씬 프로비저닝된 스냅샷을 지원합니다. 씬 프로비저닝된 스냅샷 볼륨에 대한 자세한 내용은 2.3.6절. “씬 프로비저닝된 스냅샷 볼륨” 을 참조하십시오.

참고

LVM 스냅샷은 클러스터의 노드 전반에서 지원되지 않습니다. 클러스터형 볼륨 그룹에서 스냅샷 볼륨을 생성할 수 없습니다.

스냅샷은 스냅샷을 만든 후에 변경된 데이터 영역만 복사하므로 스냅샷 기능에는 최소한의 스토리지가 필요합니다. 예를 들어 거의 업데이트되지 않는 오리진을 사용하면 원본 용량의 3 ~ 3 %가 스냅샷을 유지하기에 충분합니다.

참고

파일 시스템의 스냅샷 복사본은 가상 복사본이며, 파일 시스템의 실제 미디어 백업이 아닙니다. 스냅샷은 백업 프로시저를 대체하는 기능을 제공하지 않습니다.

스냅샷의 크기는 원본 볼륨에 대한 변경 사항을 저장하기 위해 별도로 설정된 공간 크기를 제어합니다. 예를 들어 스냅샷을 만든 후 원본을 완전히 덮어쓰는 경우 스냅샷이 변경 사항을 유지하는 원본 볼륨만큼 커야 합니다. 예상되는 변경 수준에 따라 스냅샷의 차원이 필요합니다. 예를 들어

/usr 과 같은 읽기 볼륨 스냅샷의 수명이 짧은 스냅샷에는 /home 과 같이 더 많은 쓰기 수가 표시되는 볼륨의 긴 스냅샷보다 적은 공간이 필요합니다.

스냅샷이 완전히 실행되면 원본 볼륨에서 변경 사항을 더 이상 추적할 수 없으므로 스냅샷이 유효하지 않습니다. 스냅샷의 크기를 정기적으로 모니터링해야 합니다. 그러나 스냅샷은 완전히 재구성할 수 있으므로 스토리지 용량이 있으면 스냅샷 볼륨의 크기를 늘려 드롭되지 않도록 할 수 있습니다. 반대로 스냅샷 볼륨이 필요한 것보다 크면 볼륨의 크기를 줄여 다른 논리 볼륨에 필요한 공간을 확보할 수 있습니다.

스냅샷 파일 시스템을 생성하면 원본에 대한 전체 읽기 및 쓰기 액세스가 가능합니다. 스냅샷의 청크가 변경되면 해당 청크가 표시되고 원래 볼륨에서 복사되지 않습니다.

스냅샷 기능에는 다음과 같은 몇 가지 용도가 있습니다.

- 일반적으로 데이터를 지속적으로 업데이트하는 라이브 시스템을 중단하지 않고 논리 볼륨에서 백업을 수행해야 하는 경우 스냅샷이 수행됩니다.

- 스냅샷 파일 시스템에서 fsck 명령을 실행하여 파일 시스템의 무결성을 확인하고 원래 파일 시스템에 파일 시스템 복구가 필요한지 여부를 확인할 수 있습니다.

- 스냅샷은 읽기/쓰기이므로 스냅샷을 만들고 스냅샷에 대한 테스트를 실행하여 프로덕션 데이터에 대해 애플리케이션을 테스트하여 실제 데이터를 그대로 둘 수 있습니다.

- Red Hat Virtualization과 함께 사용할 LVM 볼륨을 생성할 수 있습니다. LVM 스냅샷을 사용하여 가상 게스트 이미지의 스냅샷을 생성할 수 있습니다. 이러한 스냅샷을 사용하면 기존 게스트를 쉽게 수정하거나 추가 스토리지를 최소화하여 새 게스트를 만들 수 있습니다. Red Hat Virtualization으로 LVM 기반 스토리지 풀 생성에 대한 자세한 내용은 가상화 관리 가이드 를 참조하십시오.

스냅샷 볼륨 생성에 대한 자세한 내용은 4.4.6절. “스냅샷 볼륨 생성” 을 참조하십시오.

lvconvert 명령의

--merge 옵션을 사용하여 스냅샷을 원본 볼륨에 병합할 수 있습니다. 데이터 또는 파일이 손실되었거나 시스템을 이전 상태로 복원해야 하는 경우 이 기능에 사용하는 기능 중 하나는 시스템 롤백을 수행하는 것입니다. 스냅샷 볼륨을 병합하면 결과 논리 볼륨의 이름, 마이너 번호, UUID가 제거되고 병합된 스냅샷이 제거됩니다. 이 옵션 사용에 대한 자세한 내용은 4.4.9절. “스냅샷 볼륨 병합” 을 참조하십시오.

2.3.6. 씬 프로비저닝된 스냅샷 볼륨

Red Hat Enterprise Linux는 씬 프로비저닝된 스냅샷 볼륨을 지원합니다. 씬 스냅샷 볼륨을 사용하면 여러 가상 장치를 동일한 데이터 볼륨에 저장할 수 있습니다. 이를 통해 관리를 단순화하고 스냅샷 볼륨 간에 데이터를 공유할 수 있습니다.

모든 LVM 스냅샷 볼륨 및 모든 씬 볼륨에 대해 씬 스냅샷 볼륨은 클러스터의 노드에서 지원되지 않습니다. 스냅샷 볼륨은 하나의 클러스터 노드에서만 독점적으로 활성화되어야 합니다.

씬 스냅샷 볼륨은 다음과 같은 이점을 제공합니다.

- 씬 스냅샷 볼륨은 동일한 원본 볼륨의 스냅샷이 여러 개인 경우 디스크 사용량을 줄일 수 있습니다.

- 동일한 원본의 스냅샷이 여러 개인 경우 원본에 쓰기를 수행하면 하나의 COW 작업이 데이터를 보존합니다. 원본의 스냅샷 수를 늘리면 큰 속도 저하가 발생하지 않습니다.

- 씬 스냅샷 볼륨은 다른 스냅샷의 논리 볼륨 원본으로 사용할 수 있습니다. 이를 통해 임의 수준의 재귀 스냅샷(스냅샷 스냅샷의 하위 집합)을 사용할 수 있습니다.

- 씬 논리 볼륨의 스냅샷도 씬 논리 볼륨을 생성합니다. 이 경우 COW 작업이 필요하거나 스냅샷 자체를 작성할 때까지 데이터 공간이 사용되지 않습니다.

- 씬 스냅샷 볼륨은 원본으로 활성화할 필요가 없으므로 사용자는 원본의 비활성 스냅샷 볼륨만 있는 동안만 사용할 수 있습니다.

- 씬 프로비저닝된 스냅샷 볼륨의 원본을 삭제하면 해당 원본 볼륨의 각 스냅샷이 씬 프로비저닝된 볼륨이 됩니다. 즉, 원본 볼륨과 스냅샷을 병합하는 대신 원본 볼륨을 삭제한 다음 해당 독립 볼륨을 새 스냅샷의 원본 볼륨으로 사용하여 씬 프로비저닝된 새 스냅샷을 만들 수 있습니다.

씬 스냅샷 볼륨을 사용하는 데는 많은 이점이 있지만 이전 LVM 스냅샷 볼륨 기능이 필요에 따라 더 적합할 수 있는 몇 가지 사용 사례가 있습니다.

- 씬 풀의 청크 크기를 변경할 수 없습니다. 씬 풀에 큰 청크 크기(예: 1MB)가 있고 큰 청크 크기가 효율적이지 않은 청크 크기가 필요한 경우 이전 스냅샷 기능을 사용하도록 선택할 수 있습니다.

- 씬 스냅샷 볼륨의 크기를 제한할 수 없습니다. 스냅샷에서는 필요한 경우 씬 풀의 모든 공간을 사용합니다. 이것은 귀하의 필요에 적합하지 않을 수 있습니다.

일반적으로 사용할 스냅샷 형식을 결정할 때 사이트의 특정 요구 사항을 고려해야 합니다.

참고

씬 프로비저닝을 사용할 때는 스토리지 관리자가 스토리지 풀을 모니터링하고 용량을 늘리기 시작하는 것이 중요합니다. 씬 프로비저닝된 스냅샷 볼륨에 대한 정보를 구성 및 표시하는 방법에 대한 자세한 내용은 4.4.7절. “씬 프로비저닝된 스냅샷 볼륨 생성” 을 참조하십시오.

2.3.7. 캐시 볼륨

Red Hat Enterprise Linux 7.1 릴리스에서 LVM은 빠른 블록 장치(예: SSD 드라이브)를 더 큰 느린 블록 장치에 대한 나중 쓰기 또는 쓰기 캐시로 사용할 수 있도록 지원합니다. 사용자는 캐시 논리 볼륨을 생성하여 기존 논리 볼륨의 성능을 개선하거나 크고 느린 장치와 결합된 작고 빠른 장치로 구성된 새 캐시 논리 볼륨을 생성할 수 있습니다.

LVM 캐시 볼륨 생성에 대한 자세한 내용은 4.4.8절. “LVM 캐시 논리 볼륨 생성” 을 참조하십시오.

3장. LVM 관리 개요

이 장에서는 LVM 논리 볼륨을 구성하는 데 사용하는 관리 절차에 대해 설명합니다. 이 장에서는 관련 단계에 대한 일반적인 이해를 제공하기 위한 것입니다. 일반적인 LVM 구성 절차의 특정 단계별 예는 5장. LVM 설정 예 를 참조하십시오.

LVM 관리를 수행하는 데 사용할 수 있는 CLI 명령에 대한 설명은 4장. CLI 명령을 사용하여 LVM 관리 을 참조하십시오.

3.1. 논리 볼륨 생성 개요

다음은 LVM 논리 볼륨을 만들기 위한 단계를 요약한 것입니다.

- LVM 볼륨에 사용할 파티션을 물리 볼륨으로 초기화합니다.

- 볼륨 그룹을 만듭니다.

- 논리 볼륨을 생성합니다.

논리 볼륨을 만든 후 파일 시스템을 생성하고 마운트할 수 있습니다. 이 문서의 예제에서는 GFS2 파일 시스템을 사용합니다.

- mkfs.gfs2 명령을 사용하여 논리 볼륨에 polkit2 파일 시스템을 생성합니다.

- Cryostat 명령을 사용하여 새 마운트 지점을 만듭니다. 클러스터형 시스템에서 클러스터의 모든 노드에 마운트 지점을 생성합니다.

- 파일 시스템을 마운트합니다. 시스템의 각 노드의

fstab파일에 행을 추가할 수 있습니다.

참고

GFS2 파일 시스템은 독립형 시스템이나 클러스터 구성의 일부로 구현할 수 있지만 Red Hat Enterprise Linux 7 릴리스의 경우 Red Hat은 단일 노드 파일 시스템으로 GFS2 사용을 지원하지 않습니다. Red Hat은 클러스터 파일 시스템의 스냅샷 마운트를 위해 단일 노드 GFS2 파일 시스템을 계속 지원합니다(예: 백업 목적으로).

LVM 설정 정보의 스토리지 영역이 물리 볼륨에 있고 볼륨이 생성된 시스템이 아니기 때문에 LVM 볼륨 생성은 시스템이 독립적입니다. 스토리지를 사용하는 서버에는 로컬 복사본이 있지만 물리 볼륨에 있는 서버에서 다시 생성할 수 있습니다. LVM 버전이 호환되는 경우 물리 볼륨을 다른 서버에 연결할 수 있습니다.

3.2. 논리 볼륨에서 파일 시스템 확장

논리 볼륨에서 파일 시스템을 확장하려면 다음 단계를 수행합니다.

- 기존 볼륨 그룹에 할당되지 않은 공간이 충분한지 확인하여 논리 볼륨을 확장합니다. 그렇지 않은 경우 다음 절차를 수행합니다.

- pvcreate 명령을 사용하여 새 물리 볼륨을 생성합니다.

- Cryo stat extend 명령을 사용하여 새 물리 볼륨을 포함하도록 확장 중인 파일 시스템으로 논리 볼륨이 포함된 볼륨 그룹을 확장합니다.

- 볼륨 그룹이 큰 파일 시스템을 포함할 수 있을 만큼 커지면 lvresize 명령을 사용하여 논리 볼륨을 확장합니다.

- 논리 볼륨에서 파일 시스템의 크기를 조정합니다.

lvresize 명령의

-r 옵션을 사용하여 논리 볼륨을 확장하고 단일 명령으로 기본 파일 시스템의 크기를 조정할 수 있습니다.

3.3. 논리 볼륨 백업

lvm.conf 파일에서 이 기능을 비활성화하지 않는 한 볼륨 그룹 또는 논리 볼륨에 대한 구성 변경이 있을 때마다 메타데이터 백업 및 아카이브가 자동으로 생성됩니다. 기본적으로 메타데이터 백업은 /etc/lvm/backup 파일에 저장되고 메타데이터 아카이브는 /etc/lvm/archive 파일에 저장됩니다. /etc/lvm/archive 파일에 저장된 메타데이터 아카이브와 유지되는 아카이브 파일 수는 lvm.conf 파일에 설정할 수 있는 매개변수에 따라 결정됩니다. 일일 시스템 백업에는 백업에 /etc/lvm 디렉터리의 내용이 포함되어야 합니다.

메타데이터 백업은 논리 볼륨에 포함된 사용자 및 시스템 데이터를 백업하지 않습니다.

Cryostat cfg backup 명령을 사용하여

/etc/lvm/backup 파일에 메타데이터를 수동으로 백업할 수 있습니다. Cryostat cfgrestore 명령을 사용하여 메타데이터를 복원할 수 있습니다. Cryo statcfgbackup 및 Cryo statcfgrestore 명령은 4.3.13절. “볼륨 그룹 메타데이터 백업” 에 설명되어 있습니다.

3.4. 로깅

모든 메시지 출력은 다음과 같이 로깅 수준을 별도로 선택할 수 있는 로깅 모듈을 통해 전달됩니다.

- 표준 출력/오류

- syslog

- 로그 파일

- 외부 로그 기능

로깅 수준은 부록 B. LVM 구성 파일 에 설명된

/etc/lvm/lvm.conf 파일에 설정됩니다.

3.5. 메타데이터 데몬(lvmetad)

LVM에서는 데몬(lvmetad) 및

udev 규칙을 통해 구현된 중앙 메타데이터 캐시를 선택적으로 사용할 수 있습니다. 메타데이터 데몬은 두 가지 주요 용도가 있습니다. LVM 명령의 성능을 개선하고 udev 가 시스템에서 사용 가능하게 되면 논리 볼륨 또는 전체 볼륨 그룹을 자동으로 활성화할 수 있습니다.

lvm.conf 구성 파일에서 global/use_lvmetad 변수가 1로 설정된 경우 LVM은 데몬을 사용하도록 구성됩니다. 이는 기본값입니다. lvm.conf 구성 파일에 대한 자세한 내용은 부록 B. LVM 구성 파일 을 참조하십시오.

참고

lvmetad 데몬은 현재 클러스터의 노드에서 지원되지 않으며 잠금 유형이 로컬 파일 기반 잠금이어야 합니다. lvmconf --enable-cluster/--disable-cluster 명령을 사용하면

use_lvmetad 설정(lock _type=3의 경우 0이어야 함)을 포함하여 lvm.conf 파일이 적절하게 구성됩니다. 그러나 Pacemaker 클러스터에서 ocf:heartbeat:clvm 리소스 에이전트 자체는 이러한 매개변수를 시작 절차의 일부로 설정합니다.

다음 명령을 사용하여

use_lvmetad 의 값을 1에서 0으로 변경하는 경우 lvmetad 서비스를 수동으로 재부팅하거나 중지해야 합니다.

# systemctl stop lvm2-lvmetad.service

일반적으로 각 LVM 명령은 디스크 검사를 실행하여 관련 물리 볼륨을 찾아 볼륨 그룹 메타데이터를 읽습니다. 그러나 메타데이터 데몬이 실행 중이고 활성화된 경우 이 비용이 많이 드는 검사를 건너뛸 수 있습니다. 대신 lvmetad 데몬은

udev 규칙을 사용하여 사용 가능하게 되면 각 장치를 한 번만 검사합니다. 이를 통해 상당한 양의 I/O를 절약하고 특히 많은 디스크가 있는 시스템에서 LVM 작업을 완료하는 데 필요한 시간을 줄일 수 있습니다.

런타임 시(예: 핫플러그 또는 iSCSI를 통해) 새 볼륨 그룹을 사용할 수 있게 되면 사용할 수 있도록 논리 볼륨을 활성화해야 합니다. lvmetad 데몬이 활성화되면

lvm.conf 구성 파일의 activation/auto_activation_volume_list 옵션을 사용하여 자동으로 활성화해야 하는 볼륨 그룹 또는 논리 볼륨 목록을 구성할 수 있습니다. lvmetad 데몬이 없으면 수동 활성화가 필요합니다.

참고

lvmetad 데몬이 실행 중인 경우 pvscan --cache device 명령을 실행할 때

/etc/lvm/lvm.conf 파일의 filter = 설정이 적용되지 않습니다. 장치를 필터링하려면 global_filter = 설정을 사용해야 합니다. 글로벌 필터를 장애가 발생한 장치는 LVM에서 열지 않으며 스캔하지 않습니다. 예를 들어 VM에서 LVM 장치를 사용하는 경우 글로벌 필터를 사용해야 할 수 있으며 VM의 장치 내용이 물리적 호스트에서 스캔되지 않도록 해야 합니다.

3.6. lvm 명령을 사용하여 LVM 정보 표시

lvm 명령은 LVM 지원 및 구성에 대한 정보를 표시하는 데 사용할 수 있는 몇 가지 기본 제공 옵션을 제공합니다.

- LVM devtypes알려진 빌드 블록 장치 유형(Red Hat Enterprise Linux 릴리스 6.6 이상)을 표시합니다.

- LVM 형식알려진 메타데이터 형식을 표시합니다.

- LVM 도움말LVM 도움말 텍스트를 표시합니다.

- LVM 분리알려진 논리 볼륨 세그먼트 유형을 표시합니다.

- LVM 태그이 호스트에 정의된 태그를 표시합니다. LVM 개체 태그에 대한 자세한 내용은 부록 D. LVM 오브젝트 태그 을 참조하십시오.

- LVM 버전현재 버전 정보를 표시합니다.

4장. CLI 명령을 사용하여 LVM 관리

이 장에서는 LVM CLI(명령줄 인터페이스) 명령으로 수행할 수 있는 개별 관리 작업을 요약하여 논리 볼륨을 생성하고 유지 관리합니다.

LVM CLI(명령줄 인터페이스) 외에도 SSM(System Storage Manager)을 사용하여 LVM 논리 볼륨을 구성할 수 있습니다. LVM과 함께 SSM을 사용하는 방법에 대한 자세한 내용은 스토리지 관리 가이드 를 참조하십시오.

4.1. CLI 명령 사용

모든 LVM CLI 명령에는 몇 가지 일반적인 기능이 있습니다.

명령줄 인수에 크기가 필요한 경우 항상 단위를 명시적으로 지정할 수 있습니다. 단위를 지정하지 않으면 기본값은 일반적으로 KB 또는 MB입니다. LVM CLI 명령은 분수를 허용하지 않습니다.

명령줄 인수에 단위를 지정하는 경우 LVM은 대소문자를 구분하지 않습니다. M 또는 m은 동일합니다. 예를 들어 2(여러s의 1024)의 전원이 사용됩니다. 그러나 명령에

--units 인수를 지정하면 소문자가 1024인 단위로 장치 수가 1024임을 나타냅니다. 대문자는 단위가 1000개임을 나타냅니다.

명령에서 볼륨 그룹 또는 논리 볼륨 이름을 인수로 사용하는 경우 전체 경로 이름은 선택 사항입니다. Cryostat0이라는 볼륨 그룹에서

lvol0 이라는 논리 볼륨을 Cryostat 0 /lvol0 으로 지정할 수 있습니다. 볼륨 그룹 목록이 필요하지만 비어 있는 경우 모든 볼륨 그룹 목록을 대체합니다. 논리 볼륨 목록이 필요하지만 볼륨 그룹이 제공되는 경우 해당 볼륨 그룹의 모든 논리 볼륨 목록을 대체합니다. 예를 들어 lvdisplay Cryostat0 명령은 볼륨 그룹 Cryostat 0 의 모든 논리 볼륨을 표시합니다.

모든 LVM 명령은

-v 인수를 허용하며, 출력 세부 정보 표시 수준을 높이기 위해 여러 번 입력할 수 있습니다. 예를 들어 다음 예제에서는 lvcreate 명령의 기본 출력을 보여줍니다.

# lvcreate -L 50MB new_vg

Rounding up size to full physical extent 52.00 MB

Logical volume "lvol0" created

다음 명령은

-v 인수와 함께 lvcreate 명령의 출력을 보여줍니다.

# lvcreate -v -L 50MB new_vg

Finding volume group "new_vg"

Rounding up size to full physical extent 52.00 MB

Archiving volume group "new_vg" metadata (seqno 4).

Creating logical volume lvol0

Creating volume group backup "/etc/lvm/backup/new_vg" (seqno 5).

Found volume group "new_vg"

Creating new_vg-lvol0

Loading new_vg-lvol0 table

Resuming new_vg-lvol0 (253:2)

Clearing start of logical volume "lvol0"

Creating volume group backup "/etc/lvm/backup/new_vg" (seqno 5).

Logical volume "lvol0" created

-vv,-vvv 또는 - vvvv 인수를 사용하여 명령 실행에 대한 자세한 내용을 표시할 수도 있습니다. 현재 -vvv 인수는 최대 정보 양을 제공합니다. 다음 예제에서는 -vvvv 인수가 지정된 lvcreate 명령에 대한 처음 몇 줄의 출력만 보여줍니다.

# lvcreate -vvvv -L 50MB new_vg

#lvmcmdline.c:913 Processing: lvcreate -vvvv -L 50MB new_vg

#lvmcmdline.c:916 O_DIRECT will be used

#config/config.c:864 Setting global/locking_type to 1

#locking/locking.c:138 File-based locking selected.

#config/config.c:841 Setting global/locking_dir to /var/lock/lvm

#activate/activate.c:358 Getting target version for linear

#ioctl/libdm-iface.c:1569 dm version OF [16384]

#ioctl/libdm-iface.c:1569 dm versions OF [16384]

#activate/activate.c:358 Getting target version for striped

#ioctl/libdm-iface.c:1569 dm versions OF [16384]

#config/config.c:864 Setting activation/mirror_region_size to 512

...

명령의

--help 인수를 사용하여 LVM CLI 명령에 대한 도움말을 표시할 수 있습니다.

# commandname --help

명령의 도움말 페이지를 표시하려면 man 명령을 실행합니다.

# man commandname

man lvm 명령은 LVM에 대한 일반 온라인 정보를 제공합니다.

모든 LVM 오브젝트는 오브젝트를 만들 때 할당된 UUID로 내부적으로 참조됩니다. 이 기능은 볼륨 그룹에 속하는

/dev/sdf 라는 물리 볼륨을 제거하고 다시 연결할 때 /dev/sdk 임을 확인할 수 있습니다. UUID로 물리 볼륨을 식별하고 장치 이름이 아니므로 LVM은 물리 볼륨을 계속 찾습니다. 물리 볼륨을 생성할 때 물리 볼륨의 UUID를 지정하는 방법에 대한 자세한 내용은 6.3절. “물리 볼륨 메타데이터 복구” 을 참조하십시오.

4.2. 물리 볼륨 관리

이 섹션에서는 물리 볼륨 관리의 다양한 측면을 수행하는 명령에 대해 설명합니다.

4.2.1. 물리 볼륨 생성

다음 하위 섹션에서는 물리 볼륨을 만드는 데 사용되는 명령을 설명합니다.

4.2.1.1. 파티션 유형 설정

물리 볼륨에 전체 디스크 장치를 사용하는 경우 디스크에 파티션 테이블이 없어야 합니다. Cryostat 디스크 파티션의 경우 partition id는 Cryostat 또는 cfdisk 명령 또는 이와 동등한 를 사용하여 0x8e로 설정해야 합니다. 전체 디스크 장치의 경우 파티션 테이블만 지워야 하므로 해당 디스크의 모든 데이터를 효과적으로 삭제합니다. 다음 명령을 사용하여 첫 번째 섹터를 0으로 기존 파티션 테이블을 제거할 수 있습니다.

# dd if=/dev/zero of=PhysicalVolume bs=512 count=14.2.1.2. 물리 볼륨 초기화

pvcreate 명령을 사용하여 물리 볼륨으로 사용할 블록 장치를 초기화합니다. 초기화는 파일 시스템의 포맷과 유사합니다.

다음 명령은 LVM 논리 볼륨의 일부로 나중에 사용할 수 있도록

/dev/sdd,/dev/sde, /dev/sdf 를 LVM 물리 볼륨으로 초기화합니다.

# pvcreate /dev/sdd /dev/sde /dev/sdf

전체 디스크가 아닌 파티션을 초기화하려면 파티션에서 pvcreate 명령을 실행합니다. 다음 예제에서는 LVM 논리 볼륨의 일부로 나중에 사용할 수 있도록

/dev/hdb1 파티션을 LVM 물리 볼륨으로 초기화합니다.

# pvcreate /dev/hdb14.2.1.3. 블록 장치 검색

다음 예와 같이 lvmdiskscan 명령을 사용하여 물리 볼륨으로 사용할 수 있는 블록 장치를 스캔할 수 있습니다.

# lvmdiskscan

/dev/ram0 [ 16.00 MB]

/dev/sda [ 17.15 GB]

/dev/root [ 13.69 GB]

/dev/ram [ 16.00 MB]

/dev/sda1 [ 17.14 GB] LVM physical volume

/dev/VolGroup00/LogVol01 [ 512.00 MB]

/dev/ram2 [ 16.00 MB]

/dev/new_vg/lvol0 [ 52.00 MB]

/dev/ram3 [ 16.00 MB]

/dev/pkl_new_vg/sparkie_lv [ 7.14 GB]

/dev/ram4 [ 16.00 MB]

/dev/ram5 [ 16.00 MB]

/dev/ram6 [ 16.00 MB]

/dev/ram7 [ 16.00 MB]

/dev/ram8 [ 16.00 MB]

/dev/ram9 [ 16.00 MB]

/dev/ram10 [ 16.00 MB]

/dev/ram11 [ 16.00 MB]

/dev/ram12 [ 16.00 MB]

/dev/ram13 [ 16.00 MB]

/dev/ram14 [ 16.00 MB]

/dev/ram15 [ 16.00 MB]

/dev/sdb [ 17.15 GB]

/dev/sdb1 [ 17.14 GB] LVM physical volume

/dev/sdc [ 17.15 GB]

/dev/sdc1 [ 17.14 GB] LVM physical volume

/dev/sdd [ 17.15 GB]

/dev/sdd1 [ 17.14 GB] LVM physical volume

7 disks

17 partitions

0 LVM physical volume whole disks

4 LVM physical volumes

4.2.2. 물리 볼륨 표시

LVM 물리 볼륨의 속성을 표시하는 데 사용할 수 있는 명령은 pvs,pvdisplay, pvscan 입니다.

pvs 명령은 물리 볼륨 정보를 구성 가능한 형식으로 제공하여 물리 볼륨당 한 행을 표시합니다. pvs 명령은 많은 형식 제어를 제공하며 스크립팅에 유용합니다. pvs 명령을 사용하여 출력을 사용자 지정하는 방법에 대한 자세한 내용은 4.8절. “LVM에 대한 사용자 정의 보고” 을 참조하십시오.

pvdisplay 명령은 각 물리 볼륨에 대한 자세한 다중 줄 출력을 제공합니다. 고정된 형식으로 물리 속성(크기, 확장 영역, 볼륨 그룹 등)을 표시합니다.

다음 예제에서는 단일 물리 볼륨에 대한 pvdisplay 명령의 출력을 보여줍니다.

# pvdisplay

--- Physical volume ---

PV Name /dev/sdc1

VG Name new_vg

PV Size 17.14 GB / not usable 3.40 MB

Allocatable yes

PE Size (KByte) 4096

Total PE 4388

Free PE 4375

Allocated PE 13

PV UUID Joqlch-yWSj-kuEn-IdwM-01S9-XO8M-mcpsVe

pvscan 명령은 물리 볼륨에 대해 시스템에서 지원되는 모든 LVM 블록 장치를 검사합니다.

다음 명령은 발견된 모든 물리적 장치를 표시합니다.

# pvscan

PV /dev/sdb2 VG vg0 lvm2 [964.00 MB / 0 free]

PV /dev/sdc1 VG vg0 lvm2 [964.00 MB / 428.00 MB free]

PV /dev/sdc2 lvm2 [964.84 MB]

Total: 3 [2.83 GB] / in use: 2 [1.88 GB] / in no VG: 1 [964.84 MB]

이 명령은 특정 물리 볼륨을 스캔하지 않도록

lvm.conf 파일에 필터를 정의할 수 있습니다. 필터를 사용하여 스캔할 장치를 제어하는 방법에 대한 자세한 내용은 4.5절. “필터를 사용하여 LVM 장치 스캔 제어” 을 참조하십시오.

4.2.3. 물리 볼륨의 할당 방지

pvchange 명령을 사용하여 하나 이상의 물리 볼륨의 사용 가능한 공간에 물리 확장 영역을 할당하지 못할 수 있습니다. 디스크 오류가 있거나 물리 볼륨을 제거하는 경우 이 작업이 필요할 수 있습니다.

다음 명령은

/dev/sdk1 의 물리 확장 영역 할당을 허용하지 않습니다.

# pvchange -x n /dev/sdk1

pvchange 명령의

-xy 인수를 사용하여 이전에 허용되지 않은 위치에서 할당을 허용할 수도 있습니다.

4.2.4. 물리 볼륨 크기 조정

어떠한 이유로든 기본 블록 장치의 크기를 변경해야 하는 경우 pvresize 명령을 사용하여 LVM을 새 크기로 업데이트합니다. LVM에서 물리 볼륨을 사용하는 동안 이 명령을 실행할 수 있습니다.

4.2.5. 물리 볼륨 제거

LVM에서 장치를 더 이상 사용할 필요가 없는 경우 pvremove 명령을 사용하여 LVM 레이블을 제거할 수 있습니다. pvremove 명령을 실행하면 빈 물리 볼륨의 LVM 메타데이터가 제로됩니다.

제거하려는 물리 볼륨이 현재 볼륨 그룹의 일부인 경우 4.3.7절. “볼륨 그룹에서 물리 볼륨 제거” 에 설명된 대로, 볼륨 그룹에서 해당 볼륨 을 제거해야 합니다.

# pvremove /dev/ram15

Labels on physical volume "/dev/ram15" successfully wiped

4.3. 볼륨 그룹 관리

이 섹션에서는 볼륨 그룹 관리의 다양한 측면을 수행하는 명령에 대해 설명합니다.

4.3.1. 볼륨 그룹 만들기

하나 이상의 물리 볼륨에서 볼륨 그룹을 만들려면 Cryostat create 명령을 사용합니다. Cryo statcreate 명령은 이름으로 새 볼륨 그룹을 생성하고 하나 이상의 물리 볼륨을 추가합니다.

다음 명령은 물리 볼륨

/dev/sdd 1 및 /dev/sde1 을 포함하는 Cryostat1이라는 볼륨 그룹을 생성합니다.

# vgcreate vg1 /dev/sdd1 /dev/sde1

물리 볼륨을 사용하여 볼륨 그룹을 만들 때 디스크 공간은 기본적으로 4MB 확장 영역으로 나뉩니다. 이 범위는 논리 볼륨의 크기를 늘리거나 줄일 수 있는 최소 크기입니다. 많은 수의 Extent는 논리 볼륨의 I/O 성능에 영향을 미치지 않습니다.

기본 범위 크기가 적합하지 않은 경우

-s 옵션으로 범위 크기를 지정할 수 있습니다. Cryostat create 명령의 -p 및 -l 인수를 사용하여 볼륨 그룹이 보유할 수 있는 물리 볼륨 또는 논리 볼륨 수에 제한을 설정할 수 있습니다.

기본적으로 볼륨 그룹은 동일한 물리 볼륨에 병렬 스트라이프를 배치하지 않는 등의 공통 규칙에 따라 물리 확장 영역을 할당합니다. 이는 일반적인 할당 정책입니다. Cryostat create 명령의 --alloc 인수를 사용하여 연속적인,어디에서나 또는 클링의 할당 정책을 지정할 수 있습니다. 일반적으로 일반 이외의 할당 정책은 비정상적 또는 비표준 범위 할당을 지정해야 하는 특수한 경우에만 필요합니다. LVM에서 물리 확장 영역을 할당하는 방법에 대한 자세한 내용은 4.3.2절. “LVM Allocation” 을 참조하십시오.

LVM 볼륨 그룹과 기본 논리 볼륨은 다음 레이아웃을 사용하여

/dev 디렉터리의 장치 특수 파일 디렉터리 트리에 포함됩니다.

/dev/vg/lv/

예를 들어

myvg1 및 myvg2 두 개의 볼륨 그룹을 생성하는 경우 각각 lv01,lv02, lv03 이라는 세 개의 논리 볼륨이 있는 경우 6개의 장치 특수 파일이 생성됩니다.

/dev/myvg1/lv01 /dev/myvg1/lv02 /dev/myvg1/lv03 /dev/myvg2/lv01 /dev/myvg2/lv02 /dev/myvg2/lv03

해당 논리 볼륨이 현재 활성화되어 있지 않은 경우 장치 특수 파일이 존재하지 않습니다.

LVM의 최대 장치 크기는 64비트 CPU에서 8 Exabytes입니다.

4.3.2. LVM Allocation

LVM 작업에서 하나 이상의 논리 볼륨에 물리 확장 영역을 할당해야 하는 경우 할당은 다음과 같이 진행됩니다.

- 볼륨 그룹에서 할당되지 않은 물리 확장 영역의 전체 세트를 고려하여 생성됩니다. 명령줄 끝에 물리 확장 영역 범위를 제공하는 경우 지정된 물리 볼륨에 있는 해당 범위 내에서 할당되지 않은 물리 확장 영역만 고려해야 합니다.

- 각 할당 정책은 가장 엄격한 정책(연동)으로 시작하여

--alloc옵션을 사용하여 지정된 할당 정책으로 끝나거나 특정 논리 볼륨 또는 볼륨 그룹의 기본값으로 설정됩니다.각 정책에 대해 할당 정책에 따라 최대한 많은 공간을 할당해야 하는 빈 논리 볼륨 공간의 가장 낮은 수의 논리 확장에서 작업할 수 있습니다. 더 많은 공간이 필요한 경우 LVM은 다음 정책으로 이동합니다.

할당 정책 제한 사항은 다음과 같습니다.

연속적인할당 정책을 사용하려면 논리 볼륨의 첫 번째 논리 범위가 아닌 논리 확장 영역의 물리적 위치가 바로 앞의 논리 확장 영역의 물리적 위치에 인접해야 합니다.논리 볼륨이 제거되거나 미러링되면연속할당 제한이 공간이 필요한 각 스트라이프 또는 미러 이미지(leg)에 독립적으로 적용됩니다.- 복제의 할당 정책을 사용하려면 논리 볼륨에 사용된 물리 볼륨을 해당 논리 볼륨의 앞부분에서 하나 이상의 논리 범위에서 이미 사용 중인 기존 논리 볼륨에 추가해야 합니다.

구성 매개변수allocation/cling_tag_list가 정의된 경우 나열된 태그 중 하나가 두 물리 볼륨에 있는 경우 두 개의 물리 볼륨이 일치하는 것으로 간주됩니다. 이를 통해 유사한 속성(예: 물리 위치)이 있는 물리 볼륨 그룹에 태그를 지정하고 할당 목적으로 동일하게 처리될 수 있습니다. LVM 태그와 함께 복제 정책을 사용하여 LVM 볼륨을 확장할 때 사용할 추가 물리 볼륨을 지정하는 방법에 대한 자세한 내용은 4.4.19절. “클링 할당 정책을 사용하여 논리 볼륨 확장” 을 참조하십시오.논리 볼륨이 제거되거나 미러링되면 클링 할당제한이공간이 필요한 각 스트라이프 또는 미러 이미지(leg)에 독립적으로 적용됩니다. 일반할당 정책은 병렬 논리 볼륨 내의 동일한 오프셋에서 병렬 논리 볼륨(즉, 다른 스트라이프 또는 미러 이미지/leg)에 이미 할당된 논리 확장 영역과 동일한 물리 볼륨을 공유하는 물리 범위를 선택하지 않습니다.미러 데이터를 유지하기 위해 논리 볼륨과 동시에 미러 로그를 할당할 때normal의 할당 정책은 먼저 로그 및 데이터에 대해 다른 물리 볼륨을 선택하려고 합니다. 이 옵션을 사용할 수 없고allocation/mirror_logs_require_separate_pvs구성 매개 변수가 0으로 설정된 경우 로그에서 데이터의 일부와 물리 볼륨을 공유할 수 있습니다.마찬가지로, 씬 풀 메타데이터를 할당할 때normal의 할당 정책은 할당/thin_pool_metadata_require_separate_pvs 구성 매개변수 값에 따라 미러 로그 할당과 동일한 고려 사항을 따릅니다.- 할당 요청을 충족하기에 사용 가능한 확장 영역이 충분하지만 일반 할당 정책에서 사용하지 않는 경우 동일한 물리 볼륨에 두 개의 스트라이프를 배치하여 성능이 저하되는 경우에도 모든 위치에서 할당 정책을 사용합니다.

할당 정책은 Cryostat change 명령을 사용하여 변경할 수 있습니다.

참고

정의된 할당 정책에 따라 이 섹션에 설명된 레이아웃 이외의 레이아웃 동작에 의존하는 경우 이후 버전의 코드에서 변경될 수 있습니다.If you rely on any layout behavior beyond that documented in this section according to the defined allocation policy, you should note that this might change in future versions of the code. 예를 들어 할당에 사용할 수 있는 사용 가능한 물리 확장 영역 수가 동일한 두 개의 빈 물리 볼륨을 명령줄에 제공하는 경우 LVM은 현재 나열된 순서대로 각 볼륨을 사용하는 것을 고려하며 향후 릴리스에서는 해당 속성을 유지함을 보장하지 않습니다. 특정 논리 볼륨에 대한 특정 레이아웃을 얻는 것이 중요한 경우 일련의 lvcreate 및 lvconvert 단계를 통해 빌드해야 하므로 각 단계에 적용된 할당 정책은 LVM을 레이아웃에 의존하지 않습니다.

할당 프로세스가 특정 사례에서 작동하는 방식을 보려면, 예를 들어 명령에

-vvv 옵션을 추가하여 디버그 로깅 출력을 읽을 수 있습니다.

4.3.3. 클러스터에서 볼륨 그룹 만들기

단일 노드에서 생성하는 것처럼 Cryostat create 명령을 사용하여 클러스터 환경에서 CLVM 볼륨 그룹을 생성합니다.

참고

Red Hat Enterprise Linux 7에서 클러스터는 Pacemaker를 통해 관리됩니다. 클러스터형 LVM 논리 볼륨은 Pacemaker 클러스터와 함께만 지원되며 클러스터 리소스로 구성해야 합니다. 클러스터에서 LVM 볼륨 구성에 대한 일반적인 정보는 1.4절. “Red Hat High Availability Cluster의 LVM 논리 볼륨” 에서 참조하십시오.

클러스터의 멤버가 공유하는 볼륨 그룹은 Cryostat create -cy 또는 Cryostat change -cy 명령을 사용하여 클러스터형 특성을 사용하여 생성해야 합니다. CLVMD가 실행 중인 경우 클러스터형 특성이 자동으로 설정됩니다. 이 클러스터형 속성은 이 볼륨 그룹을 CLVMD에서 관리하고 보호해야 함을 나타냅니다. 클러스터에서 공유되지 않고 단일 호스트에만 표시되어야 하는 볼륨 그룹을 생성하는 경우, 이 클러스터형 특성은 -cn 또는 Cryostat change -cn 명령을 사용하여 비활성화해야 합니다.

기본적으로 공유 스토리지의 클러스터형 특성으로 생성된 볼륨 그룹은 공유 스토리지에 액세스할 수 있는 모든 컴퓨터에 표시됩니다. 그러나 local인 볼륨 그룹을 생성할 수 있습니다. 이 볼륨 그룹은 클러스터의 하나의 노드에만 표시되는

볼륨 그룹을 생성할 수 있습니다.

다음 명령은 클러스터 환경에서 실행할 때 명령이 실행된 노드에 로컬인 볼륨 그룹을 생성합니다. 이 명령은 물리 볼륨

/dev/sdd 1 및 /dev/sde1 이 포함된 local volume이라는 로컬 볼륨을 생성합니다.

# vgcreate -c n vg1 /dev/sdd1 /dev/sde1

기존 볼륨 그룹이 volumes 명령을 사용하여 클러스터형 볼륨 그룹인지 확인할 수 있습니다. 이 그룹은 볼륨이 클러스터형 경우 c 속성을 표시합니다. 다음 명령은 볼륨 그룹의 특성 usx

00 및 testvg1 을 표시합니다. 이 예에서는 Attr 제목 아래에 c 속성으로 표시된 대로 testvg1 은 클러스터된 반면, testvg1은 클러스터형 상태가 아닙니다.

# vgs

VG #PV #LV #SN Attr VSize VFree

VolGroup00 1 2 0 wz--n- 19.88G 0

testvg1 1 1 0 wz--nc 46.00G 8.00M

4.3.4. 볼륨 그룹에 물리 볼륨 추가

기존 볼륨 그룹에 물리 볼륨을 추가하려면 Cryostatextend 명령을 사용합니다. Cryo stat extend 명령은 하나 이상의 사용 가능한 물리 볼륨을 추가하여 볼륨 그룹의 용량을 늘립니다.

다음 명령은 물리 볼륨

/dev/sdf1 을 볼륨 그룹 Cryostat 1에 추가합니다.

# vgextend vg1 /dev/sdf14.3.5. 볼륨 그룹 표시

LVM 볼륨 그룹의 속성을 표시하는 데 사용할 수 있는 명령은 두 가지가 있습니다. protects 및 Cryostat display .

모든 디스크를 볼륨 그룹으로 스캔하고 LVM 캐시 파일을 다시 빌드하는 Cryostatscan 명령도 볼륨 그룹을 표시합니다. Cryostatscan 명령에 대한 자세한 내용은 4.3.6절. “볼륨 그룹용 디스크 스캔에서 캐시 파일 빌드” 을 참조하십시오.

Cryo stats 명령은 볼륨 그룹 정보를 구성 가능한 형식으로 제공하여 볼륨 그룹당 한 행을 표시합니다. Cryostats 명령은 많은 형식 제어를 제공하며 스크립팅에 유용합니다. output을 사용자 지정하는 방법에 대한 자세한 내용은 4.8절. “LVM에 대한 사용자 정의 보고” 을 참조하십시오.

Cryo stat display 명령은 볼륨 그룹 속성(예: 크기, 확장 영역, 물리 볼륨 수 등)을 고정된 형식으로 표시합니다. 다음 예제에서는 볼륨 그룹

new_vg 에 대한 Cryostatdisplay 명령의 출력을 보여줍니다. 볼륨 그룹을 지정하지 않으면 기존 볼륨 그룹이 모두 표시됩니다.

# vgdisplay new_vg

--- Volume group ---

VG Name new_vg

System ID

Format lvm2

Metadata Areas 3

Metadata Sequence No 11

VG Access read/write

VG Status resizable

MAX LV 0

Cur LV 1

Open LV 0

Max PV 0

Cur PV 3

Act PV 3

VG Size 51.42 GB

PE Size 4.00 MB

Total PE 13164

Alloc PE / Size 13 / 52.00 MB

Free PE / Size 13151 / 51.37 GB

VG UUID jxQJ0a-ZKk0-OpMO-0118-nlwO-wwqd-fD5D32

4.3.6. 볼륨 그룹용 디스크 스캔에서 캐시 파일 빌드

Cryo stats can 명령은 LVM 물리 볼륨 및 볼륨 그룹을 찾는 시스템에서 지원되는 모든 디스크 장치를 검사합니다. 이렇게 하면 현재 LVM 장치 목록을 유지 관리하는

/etc/lvm/cache/.cache 파일에 LVM 캐시 파일이 빌드됩니다.

LVM은 시스템 시작 시 및 LVM 작업 중 LVM 작업 중 또는 LVM이 불일치 를 감지하는 경우와 같이 LVM을 자동으로 실행합니다.

참고

하드웨어 구성을 변경하고 노드에서 장치를 추가하거나 삭제할 때 Cryostatscan 명령을 수동으로 실행하여 시스템 부팅 시 존재하지 않은 시스템에 새 장치를 표시해야 할 수 있습니다. 예를 들어 SAN의 시스템에 새 디스크를 추가하거나 물리 볼륨으로 레이블이 지정된 새 디스크를 핫플러그하는 경우 이 작업이 필요할 수 있습니다.

/etc/lvm/lvm.conf 파일에 필터를 정의하여 특정 장치를 방지하도록 검사를 제한할 수 있습니다. 필터를 사용하여 스캔할 장치를 제어하는 방법에 대한 자세한 내용은 4.5절. “필터를 사용하여 LVM 장치 스캔 제어” 을 참조하십시오.

다음 예제에서는 Cryostatscan 명령 의 출력을 보여줍니다.

# vgscan

Reading all physical volumes. This may take a while...

Found volume group "new_vg" using metadata type lvm2

Found volume group "officevg" using metadata type lvm2

4.3.7. 볼륨 그룹에서 물리 볼륨 제거

볼륨 그룹에서 사용되지 않는 물리 볼륨을 제거하려면 Cryostatreduce 명령을 사용합니다. Cryo stat reduce 명령은 하나 이상의 빈 물리 볼륨을 제거하여 볼륨 그룹의 용량을 줄입니다. 이렇게 하면 해당 물리 볼륨을 다른 볼륨 그룹에서 사용하거나 시스템에서 제거할 수 있습니다.

볼륨 그룹에서 물리 볼륨을 제거하기 전에 pvdisplay 명령을 사용하여 논리 볼륨에서 물리 볼륨을 사용하지 않도록 할 수 있습니다.

# pvdisplay /dev/hda1

-- Physical volume ---

PV Name /dev/hda1

VG Name myvg

PV Size 1.95 GB / NOT usable 4 MB [LVM: 122 KB]

PV# 1

PV Status available

Allocatable yes (but full)

Cur LV 1

PE Size (KByte) 4096

Total PE 499

Free PE 0

Allocated PE 499

PV UUID Sd44tK-9IRw-SrMC-MOkn-76iP-iftz-OVSen7

물리 볼륨이 여전히 사용 중인 경우 pvmove 명령을 사용하여 데이터를 다른 물리 볼륨으로 마이그레이션해야 합니다. 그런 다음 Cryo stat reduce 명령을 사용하여 물리 볼륨을 제거합니다.

다음 명령은 볼륨 그룹

my_volume_group 에서 물리 볼륨 /dev/hda1 을 제거합니다.

# vgreduce my_volume_group /dev/hda1

논리 볼륨에 실패한 물리 볼륨이 포함된 경우 해당 논리 볼륨을 사용할 수 없습니다. 볼륨 그룹에서 누락된 물리 볼륨을 제거하려면 누락된 물리 볼륨에 할당된 논리 볼륨이 없는 경우 volume group에서

--removemissing 매개변수를 사용할 수 있습니다.

실패하는 물리 볼륨에 미러 세그먼트 유형의 논리 볼륨의 미러 이미지가 포함된 경우, Cryostatreduce --removemissing --

mirror sonly --force 명령을 사용하여 미러 에서 해당 이미지를 제거할 수 있습니다. 이렇게 하면 물리 볼륨에서 미러 이미지인 논리 볼륨만 제거됩니다.

LVM 미러 장애 복구에 대한 자세한 내용은 6.2절. “LVM Mirror 실패에서 복구” 을 참조하십시오. 볼륨 그룹에서 손실된 물리 볼륨을 제거하는 방법에 대한 자세한 내용은 참조하십시오. 6.5절. “볼륨 그룹에서 손실된 물리 볼륨 제거”

4.3.8. 볼륨 그룹 활성화 및 비활성화

볼륨 그룹을 생성하면 기본적으로 활성화됩니다. 즉, 해당 그룹의 논리 볼륨에 액세스할 수 있으며 변경될 수 있습니다.

볼륨 그룹을 비활성 상태로 만들어야 하므로 커널에 알 수 없는 다양한 상황이 있습니다. 볼륨 그룹을 비활성화하거나 활성화하려면 Cryostat change 명령의

-a (--available) 인수 를 사용합니다.

다음 예제에서는

my_volume_group 볼륨 그룹을 비활성화합니다.

# vgchange -a n my_volume_group

클러스터형 잠금이 활성화된 경우 한 노드 또는 'l'에서만 볼륨 그룹을 활성화 또는 비활성화하려면 'e'를 추가하여 로컬 노드에서만 볼륨 그룹을 활성화하거나/비활성화합니다. 단일 호스트 스냅샷이 있는 논리 볼륨은 한 노드에서만 사용할 수 있으므로 항상 독점적으로 활성화됩니다.

4.4.11절. “논리 볼륨 그룹의 매개 변수 변경” 에 설명된 대로 lvchange 명령을 사용하여 개별 논리 볼륨을 비활성화할 수 있습니다. 클러스터의 개별 노드에서 논리 볼륨을 활성화하는 방법에 대한 자세한 내용은 4.7절. “클러스터의 개별 노드에서 논리 볼륨 활성화” 을 참조하십시오.

4.3.9. 볼륨 그룹의 매개변수 변경

Cryo statchange 명령은 4.3.8절. “볼륨 그룹 활성화 및 비활성화” 에 설명된 대로 볼륨 그룹을 비활성화 및 활성화하는 데 사용됩니다. 이 명령을 사용하여 기존 볼륨 그룹의 여러 볼륨 그룹 매개변수를 변경할 수도 있습니다.

다음 명령은 볼륨 그룹의 최대 논리 볼륨 수를

128으로 변경합니다.

# vgchange -l 128 /dev/vg00

Cryostatchange 명령을 사용하여 변경할 수 있는 볼륨 그룹 매개변수에 대한 설명은 Cryostat change (8) 도움말 페이지를 참조하십시오.

4.3.10. 볼륨 그룹 제거

논리 볼륨이 없는 볼륨 그룹을 제거하려면 Cryostat remove 명령을 사용합니다.

# vgremove officevg

Volume group "officevg" successfully removed

4.3.11. 볼륨 그룹 분할

볼륨 그룹의 물리 볼륨을 분할하고 새 볼륨 그룹을 만들려면 Cryostat split 명령을 사용합니다.

논리 볼륨은 볼륨 그룹 간에 분할할 수 없습니다. 기존의 각 논리 볼륨은 이전 또는 새 볼륨 그룹을 구성하는 물리 볼륨에 전적으로 있어야 합니다. 그러나 필요한 경우 pvmove 명령을 사용하여 강제로 분할할 수 있습니다.

다음 예제에서는 새 볼륨 그룹

smallvg 를 원래 볼륨 그룹 bigvg 에서 분할합니다.

# vgsplit bigvg smallvg /dev/ram15

Volume group "smallvg" successfully split from "bigvg"

4.3.12. 볼륨 그룹 결합

두 개의 볼륨 그룹을 단일 볼륨 그룹으로 결합하려면 Cryostat merge 명령을 사용합니다. 볼륨의 물리 확장 크기가 같고 두 볼륨 그룹의 물리 및 논리 볼륨 요약이 대상 볼륨 그룹 제한에 적합한 경우 비활성 "소스" 볼륨을 활성 또는 "대상" 볼륨과 병합할 수 있습니다.

다음 명령은 비활성 볼륨 그룹

my_vg 를 활성 또는 비활성 볼륨 그룹 데이터베이스에 병합하여 자세한 런타임 정보를 제공합니다.

# vgmerge -v databases my_vg4.3.13. 볼륨 그룹 메타데이터 백업

lvm.conf 파일에서 비활성화하지 않는 한 메타데이터 백업 및 아카이브는 볼륨 그룹 또는 논리 볼륨에 대한 모든 구성 변경 시 자동으로 생성됩니다. 기본적으로 메타데이터 백업은 /etc/lvm/backup 파일에 저장되고 메타데이터 아카이브는 /etc/lvm/archive 파일에 저장됩니다. Cryostat cfg backup 명령을 사용하여 /etc/lvm/backup 파일에 메타데이터를 수동으로 백업할 수 있습니다.

Cryo statcfgrestore 명령은 볼륨 그룹의 메타데이터를 아카이브에서 볼륨 그룹의 모든 물리 볼륨으로 복원합니다.

physical volume metadata를 복구하기 위해

Cryostatcfgrestore 명령을 사용하는 예는 6.3절. “물리 볼륨 메타데이터 복구” 를 참조하십시오.

4.3.14. 볼륨 그룹 이름 변경

Cryostat rename 명령을 사용하여 기존 볼륨 그룹의 이름을 바꿉니다.

다음 명령 중 하나는 기존 볼륨 그룹의 이름을

my_volume_group으로 변경합니다.

# vgrename /dev/vg02 /dev/my_volume_group

# vgrename vg02 my_volume_group4.3.15. 다른 시스템으로 볼륨 그룹 이동

전체 LVM 볼륨 그룹을 다른 시스템으로 이동할 수 있습니다. 이 작업을 수행할 때 Cryostat export 및 Cryo statimport 명령을 사용하는 것이 좋습니다.

참고

Cryostat import 명령의

--force 인수를 사용할 수 있습니다. 이를 통해 누락된 물리 볼륨인 볼륨 그룹을 가져오고 나중에 Cryostatreduce --removemissing 명령을 실행할 수 있습니다.

Cryo statexport 명령을 사용하면 비활성 볼륨 그룹에 시스템에 액세스할 수 없으므로 물리 볼륨을 분리할 수 있습니다. Cryo statimport 명령을 사용하면 Cryostat export 명령으로 비활성화된 후 시스템에서 볼륨 그룹에 액세스할 수 있습니다.

한 시스템에서 다른 시스템으로 볼륨 그룹을 이동하려면 다음 단계를 수행합니다.

- 볼륨 그룹의 활성 볼륨의 파일에 액세스하는 사용자가 없는지 확인한 다음 논리 볼륨을 분리합니다.

- volume group의

-a n인수를 사용하여 볼륨 그룹을 비활성으로 표시하여 볼륨 그룹의 추가 활동을 방지합니다. - volumes export 명령을 사용하여 볼륨 그룹을 내보냅니다. 이렇게 하면 제거할 시스템에서 액세스할 수 없습니다.볼륨 그룹을 내보내면 다음 예와 같이 pvscan 명령을 실행할 때 물리 볼륨이 내보낸 볼륨 그룹에 있는 것으로 표시됩니다.

#

pvscanPV /dev/sda1 is in exported VG myvg [17.15 GB / 7.15 GB free] PV /dev/sdc1 is in exported VG myvg [17.15 GB / 15.15 GB free] PV /dev/sdd1 is in exported VG myvg [17.15 GB / 15.15 GB free] ...다음에 시스템이 종료되면 볼륨 그룹을 구성하는 디스크를 분리하고 새 시스템에 연결할 수 있습니다. - 디스크가 새 시스템에 연결되면 Cryostat import 명령을 사용하여 볼륨 그룹을 가져와 새 시스템에서 액세스할 수 있도록 합니다.

- Cryostat change 명령의

-a y인수를 사용하여 볼륨 그룹을 활성화합니다. - 파일 시스템을 마운트하여 사용할 수 있도록 합니다.

4.3.16. 볼륨 그룹 디렉터리 다시 생성

볼륨 그룹 디렉터리 및 논리 볼륨 특수 파일을 다시 생성하려면 Cryostat mknodes 명령을 사용합니다. 이 명령은 활성 논리 볼륨에 필요한

/dev 디렉토리에서 LVM2 특수 파일을 확인합니다. 누락된 특수 파일을 생성하고 사용되지 않은 파일을 제거합니다.

Cryostat mknodes 명령을 Cryostatscan 명령에 mk nodes 인수를 지정하여 통합할 수 있습니다.

4.4. 논리 볼륨 관리

이 섹션에서는 논리 볼륨 관리의 다양한 측면을 수행하는 명령에 대해 설명합니다.

4.4.1. 선형 논리 볼륨 생성

논리 볼륨을 생성하려면 lvcreate 명령을 사용합니다. 논리 볼륨의 이름을 지정하지 않으면 기본 이름

lvol# 이 사용됩니다. 여기서 # 은 논리 볼륨의 내부 번호입니다.

논리 볼륨을 생성하면 논리 볼륨이 볼륨 그룹을 구성하는 물리 볼륨의 사용 가능한 확장 영역을 사용하여 볼륨 그룹에서 분할됩니다. 일반적으로 논리 볼륨은 기본 물리 볼륨에서 사용 가능한 공간을 차세대 방식으로 사용합니다. 논리 볼륨을 수정하면 물리 볼륨에서 공간을 확보 및 재할당합니다.

다음 명령은 볼륨 그룹 Cryostat

1 에 논리 볼륨 10GB를 생성합니다.

# lvcreate -L 10G vg1

논리 볼륨 크기의 기본 단위는 메가바이트입니다. 다음 명령은 볼륨 그룹

testvg 에 testlv 라는 1500 메가바이트 선형 논리 볼륨을 생성하여 블록 장치 /dev/testvg/testlv 를 생성합니다.

# lvcreate -L 1500 -n testlv testvg

다음 명령은 볼륨 그룹 Cryostat

0 의 사용 가능한 확장 영역에서 gfslv 라는 50GB 논리 볼륨을 생성합니다.

# lvcreate -L 50G -n gfslv vg0

lvcreate 명령의

-l 인수를 사용하여 Extent에서 논리 볼륨의 크기를 지정할 수 있습니다. 이 인수를 사용하여 관련 볼륨 그룹, 논리 볼륨 또는 물리 볼륨 세트의 크기 백분율을 지정할 수도 있습니다. %VG 접미사는 볼륨 그룹의 총 크기, %FREE 접미사인 %FREE는 볼륨 그룹의 나머지 여유 공간을 나타냅니다. %PVS 접미사는 지정된 물리 볼륨의 사용 가능한 공간을 나타냅니다. 스냅샷의 경우 크기는 %ORIGIN 접미사 (100%ORIGIN)를 사용하여 원본 논리 볼륨의 전체 크기의 백분율로 표시할 수 있습니다(0%ORIGIN은 전체 원본의 공간을 제공합니다). 백분율로 표시되는 경우 크기는 새 논리 볼륨의 논리 확장 영역 수에 대한 상한을 정의합니다. 새 LV의 정확한 논리 확장 영역 수는 명령이 완료될 때까지 결정되지 않습니다.

다음 명령은 볼륨 그룹

testvg 의 총 공간의 60 %를 사용하는 mylv 라는 논리 볼륨을 생성합니다.

# lvcreate -l 60%VG -n mylv testvg

다음 명령은 볼륨 그룹

testvg 의 할당되지 않은 공간을 모두 사용하는 lv 라는 논리 볼륨을 생성합니다.

# lvcreate -l 100%FREE -n yourlv testvg

lvcreate 명령의

-l 인수를 사용하여 전체 볼륨 그룹을 사용하는 논리 볼륨을 생성할 수 있습니다. 전체 볼륨 그룹을 사용하는 논리 볼륨을 생성하는 또 다른 방법은 "Total PE" 크기를 찾고 해당 결과를 lvcreate 명령에 대한 입력으로 사용하는 것입니다.

다음 명령은

testvg 라는 볼륨 그룹을 채우는 mylv 라는 논리 볼륨을 생성합니다.

#vgdisplay testvg | grep "Total PE"Total PE 10230 #lvcreate -l 10230 -n mylv testvg

물리 볼륨을 제거해야 하는 경우 논리 볼륨을 만드는 데 사용되는 기본 물리 볼륨이 중요할 수 있으므로 논리 볼륨을 생성할 때 이러한 가능성을 고려해야 할 수 있습니다. 볼륨 그룹에서 물리 볼륨을 제거하는 방법에 대한 자세한 내용은 4.3.7절. “볼륨 그룹에서 물리 볼륨 제거” 을 참조하십시오.

볼륨 그룹의 특정 물리 볼륨에서 할당할 논리 볼륨을 만들려면 lvcreate 명령줄의 끝에 물리 볼륨 또는 볼륨을 지정합니다. 다음 명령은 물리 볼륨

/dev/sdg1 에서 할당된 testvg 볼륨 그룹에 testlv 라는 논리 볼륨을 생성합니다.

# lvcreate -L 1500 -n testlv testvg /dev/sdg1

논리 볼륨에 사용할 물리 볼륨의 확장 영역을 지정할 수 있습니다. 다음 예제는 볼륨 그룹

testvg 에서 0~24개의 물리 볼륨 /dev/sda1 의 물리 볼륨 /dev/sdb1의 물리 볼륨 /dev/sdb1 의 확장 영역 0에서 24까지의 선형 논리 볼륨을 생성합니다.

# lvcreate -l 100 -n testlv testvg /dev/sda1:0-24 /dev/sdb1:50-124

다음 예제에서는 0에서 25개의 물리 볼륨

/dev/sda1 중 25개까지의 선형 논리 볼륨을 생성한 다음 범위 100에서 논리 볼륨을 계속 실행합니다.

# lvcreate -l 100 -n testlv testvg /dev/sda1:0-25:100-

논리 볼륨의 확장 영역을 할당하는 방법에 대한 기본 정책은 볼륨 그룹과 동일한 정책을 적용하는 을 상속합니다. 이러한 정책은 lvchange 명령을 사용하여 변경할 수 있습니다. 할당 정책에 대한 자세한 내용은 4.3.1절. “볼륨 그룹 만들기” 을 참조하십시오.

4.4.2. 스트립된 볼륨 생성

순차 읽기 및 쓰기의 경우 줄인 논리 볼륨을 생성하면 데이터 I/O의 효율성을 향상시킬 수 있습니다. 스트라이핑된 볼륨에 대한 일반적인 내용은 2.3.2절. “제거된 논리 볼륨” 을 참조하십시오.

제거된 논리 볼륨을 생성할 때 lvcreate 명령의

-i 인수를 사용하여 스트라이프 수를 지정합니다. 이를 통해 논리 볼륨의 물리 볼륨 수가 결정됩니다. 스트라이프 수는 볼륨 그룹의 물리 볼륨 수보다 클 수 없습니다( --alloc을 임의의 인수가 사용되지 않는 한).

스트라이핑된 논리 볼륨을 구성하는 기본 물리 장치가 크기가 다른 경우 스트립된 볼륨의 최대 크기는 가장 작은 기본 장치에 의해 결정됩니다. 예를 들어 두 개의 분할된 스트라이프에서 최대 크기는 작은 장치의 두 배 크기입니다. 3개의 분할된 스트라이프에서 최대 크기는 가장 작은 장치의 3배 크기입니다.

다음 명령은 2개의 물리 볼륨에 걸쳐 스트라이핑된 논리 볼륨을 64킬로바이트로 만듭니다. 논리 볼륨의 크기는 50GB이며

gfslv 라는 이름이 지정되며 볼륨 그룹 Cryostat 0에서 제거됩니다.

# lvcreate -L 50G -i 2 -I 64 -n gfslv vg0

linear 볼륨과 마찬가지로 스트라이프에 사용하는 물리 볼륨의 확장 영역을 지정할 수 있습니다. 다음 명령은 두 개의 물리 볼륨에서 스트라이핑된 볼륨 100 확장 영역의 크기를

스트라이프 라고 하며 볼륨 그룹 testvg 에 있습니다. 스트라이프는 /dev/sda1 의 섹터 0-49를 사용하고 /dev/sdb1 의 50-99 섹터를 사용합니다.

# lvcreate -l 100 -i 2 -n stripelv testvg /dev/sda1:0-49 /dev/sdb1:50-99

Using default stripesize 64.00 KB

Logical volume "stripelv" created

4.4.3. RAID 논리 볼륨

LVM은 RAID0/1/4/5/6/10을 지원합니다.

참고

RAID 논리 볼륨은 클러스터가 인식되지 않습니다. RAID 논리 볼륨은 한 컴퓨터에서만 생성하고 활성화할 수 있지만 두 개 이상의 컴퓨터에서 동시에 활성화할 수 없습니다. 비독점 미러링 볼륨이 필요한 경우 4.4.4절. “미러링된 볼륨 생성” 에 설명된 대로

미러 세그먼트 유형으로 볼륨을 생성해야 합니다.

RAID 논리 볼륨을 생성하려면 raid 유형을 lvcreate 명령의

--type 인수로 지정합니다. 표 4.1. “RAID segment 유형” 가능한 RAID 세그먼트 유형을 설명합니다.

표 4.1. RAID segment 유형

| 세그먼트 유형 | 설명 | ||

|---|---|---|---|

raid1 | RAID1 미러링. 이는 -m 을 지정할 때 lvcreate 명령의 --type 인수의 기본값이지만 스트라이핑은 지정하지 않습니다. | ||

raid4 | RAID4 전용 패리티 디스크 | ||

raid5 | raid5_ls와 동일합니다. | ||

raid5_la |

| ||

raid5_ra |

| ||

raid5_ls |

| ||

raid5_rs |

| ||

raid6 | raid6_zr와 동일 | ||

raid6_zr |

| ||

raid6_nr |

| ||

raid6_nc |

| ||

raid10 |

| ||

raid0/raid0_meta (Red Hat Enterprise Linux 7.3 이상) | 스트라이핑. RAID0은 스트라이프 크기 단위로 여러 데이터 하위 볼륨에 논리 볼륨 데이터를 분산합니다. 이는 성능을 향상시키는 데 사용됩니다. 데이터 하위 볼륨에 오류가 발생하면 논리 볼륨 데이터가 손실됩니다. RAID0 볼륨 생성에 대한 자세한 내용은 4.4.3.1절. “RAID0 볼륨 생성(Red Hat Enterprise Linux 7.3 및 later)” 을 참조하십시오. |

대부분의 사용자에게 사용 가능한 5가지 기본 유형(

raid1,raid4,raid5,raid6,raid10) 중 하나를 지정하면 됩니다.

RAID 논리 볼륨을 생성할 때 LVM은 배열의 모든 데이터 또는 패리티 하위 볼륨에 대해 하나의 크기인 메타데이터 하위 볼륨을 생성합니다. 예를 들어 2방향 RAID1 배열을 생성하면 두 개의 메타데이터 하위 볼륨(

lv_rmeta_0 및 lv_rmeta_1)과 두 개의 데이터 하위 볼륨(lv_rimage_0 및 lv_rimage_1)이 생성됩니다. 마찬가지로 3방향 스트라이프(1 암시적 패리티 장치 추가) RAID4를 생성하면 4개의 메타데이터 하위 볼륨(lv_rmeta_0,lv_rmeta _2lv_rmeta_3) 및 4 데이터 하위 볼륨(lv_rimage_0 )이 생성됩니다. lv_rimage_1,lv_rimage_2, lv_rimage_3).

다음 명령은 볼륨 그룹

my_vg 에 1기가바이트인 my_lv 라는 2방향 RAID1 배열을 생성합니다.

# lvcreate --type raid1 -m 1 -L 1G -n my_lv my_vg-m 인수에 대해 지정하는 값에 따라 다른 사본 수를 사용하여 RAID1 배열을 생성할 수 있습니다. 마찬가지로 -i 인수를 사용하여 RAID 4/5/6 논리 볼륨의 스트라이프 수를 지정합니다. -I 인수를 사용하여 스트라이프 크기를 지정할 수도 있습니다.

다음 명령은 볼륨 그룹

my_vg 에서 이름이 my_lv 인 RAID5 배열(+1 암시적 패리티 드라이브)을 1기가바이트 단위로 생성합니다. LVM 스트라이핑 볼륨에 대해 수행하는 것처럼 스트라이프 수를 지정합니다. 올바른 패리티 드라이브 수가 자동으로 추가됩니다.

# lvcreate --type raid5 -i 3 -L 1G -n my_lv my_vg

다음 명령은 1 기가바이트 크기의 볼륨 그룹

my_vg 에 my_lv 라는 RAID6 배열 (3 스트라이프 + 2 암시적 패리티 드라이브)을 생성합니다.

# lvcreate --type raid6 -i 3 -L 1G -n my_lv my_vg

LVM을 사용하여 RAID 논리 볼륨을 생성한 후 다른 LVM 논리 볼륨과 마찬가지로 볼륨을 활성화, 변경, 제거, 표시 및 사용할 수 있습니다.

RAID10 논리 볼륨을 생성할 때

동기화 작업으로 논리 볼륨을 초기화하는 데 필요한 배경 I/O는 특히 많은 RAID 논리 볼륨을 생성할 때 볼륨 그룹 메타데이터 업데이트와 같은 LVM 장치에 대한 다른 I/O 작업을 충돌할 수 있습니다. 이로 인해 다른 LVM 작업이 느려질 수 있습니다.

복구 제한을 구현하여 RAID 논리 볼륨이 초기화되는 속도를 제어할 수 있습니다. lvcreate 명령의

--minrecoveryrate 및 --maxrecoveryrate 옵션을 사용하여 해당 작업의 최소 및 최대 I/O 속도를 설정하여 동기화 작업이 수행되는 속도를 제어합니다. 이러한 옵션을 다음과 같이 지정합니다.

--maxrecoveryrate 속도[bBsSkKmMgG]RAID 논리 볼륨의 최대 복구 속도를 설정하여 nominal I/O 작업을 대규모로 설정하지 않도록 합니다. Rate 는 배열의 각 장치에 대한 초당 양으로 지정됩니다. 접미사가 제공되지 않으면 kiB/sec/device로 가정합니다. 복구 속도를 0으로 설정하면 바인딩되지 않음을 의미합니다.--minrecoveryrate 속도[bBsSkKmMgG]RAID 논리 볼륨의 최소 복구 속도를 설정하여동기화작업의 I/O가 무분별 I/O가 있는 경우에도 최소 처리량을 확보합니다. Rate 는 배열의 각 장치에 대한 초당 양으로 지정됩니다. 접미사가 제공되지 않으면 kiB/sec/device로 가정합니다.

다음 명령은 최대 128 kiB/sec/device의 최대 복구 속도로 크기가 10GB인 3개의 스트라이프를 사용하여 2방향 RAID10 배열을 생성합니다. 배열의 이름은

my_lv 이며 볼륨 그룹 my_vg 에 있습니다.

# lvcreate --type raid10 -i 2 -m 1 -L 10G --maxrecoveryrate 128 -n my_lv my_vg

RAID 스크럽 작업에 대한 최소 및 최대 복구 속도를 지정할 수도 있습니다. RAID 스크럽링에 대한 자세한 내용은 4.4.3.11절. “RAID 논리 볼륨 삭제” 을 참조하십시오.

참고

LVM RAID Calculator 애플리케이션을 사용하여 RAID 스토리지에 논리 볼륨을 생성하는 명령을 생성할 수 있습니다. 이 애플리케이션은 현재 또는 계획된 스토리지에 대해 입력한 정보를 사용하여 이러한 명령을 생성합니다. LVM RAID 계산기 애플리케이션은 https://access.redhat.com/labs/lvmraidcalculator/ 에서 확인할 수 있습니다.

다음 섹션에서는 LVM RAID 장치에서 수행할 수 있는 관리 작업에 대해 설명합니다.

4.4.3.1. RAID0 볼륨 생성(Red Hat Enterprise Linux 7.3 및 later)

RAID0 볼륨을 생성하는 명령의 형식은 다음과 같습니다.

lvcreate --type raid0[_meta] --stripes Stripes --stripesize StripeSize VolumeGroup [PhysicalVolumePath ...]

표 4.2. RAID0 명령 생성 매개변수

| 매개변수 | 설명 |

|---|---|

--type raid0[_meta] | raid0 을 지정하면 메타데이터 볼륨 없이 RAID0 볼륨이 생성됩니다. raid0_meta 를 지정하면 메타데이터 볼륨이 포함된 RAID0 볼륨이 생성됩니다. RAID0은 비현실적이므로 미러링된 데이터 블록을 RAID1/10으로 저장하거나 패리티 블록을 RAID4/5/6으로 계산 및 저장할 필요가 없습니다. 따라서 미러링된 또는 패리티 블록의 재동기화 진행 상황에 대한 상태를 유지하기 위해 메타데이터 볼륨이 필요하지 않습니다. 그러나 RAID0에서 RAID4/5/6/10으로의 변환에 메타데이터 볼륨이 필요하며, raid0_meta 를 지정하면 각 할당 실패를 방지하기 위해 해당 메타데이터 볼륨을 사전 할당해야 합니다. |

--stripes Stripes | 논리 볼륨을 분산할 장치 수를 지정합니다. |

--stripesize StripeSize | 각 스트라이프의 크기를 킬로바이트로 지정합니다. 이는 다음 장치로 이동하기 전에 하나의 장치에 기록된 데이터 양입니다. |

VolumeGroup | 사용할 볼륨 그룹을 지정합니다. |

PhysicalVolumePath ... | 사용할 장치를 지정합니다. 이 값을 지정하지 않으면 LVM에서 각 스트라이프에 하나씩 Stripes 옵션으로 지정된 장치 수를 선택합니다. |

4.4.3.2. 선형 장치를 RAID 장치로 변환

lvconvert 명령의

--type 인수를 사용하여 기존 선형 논리 볼륨을 RAID 장치로 변환할 수 있습니다.

다음 명령은 볼륨 그룹

my_vg 의 선형 논리 볼륨 my_lv 를 2방향 RAID1 배열로 변환합니다.

# lvconvert --type raid1 -m 1 my_vg/my_lv

RAID 논리 볼륨은 메타데이터 및 데이터 하위 볼륨 쌍으로 구성되기 때문에 선형 장치를 RAID1 배열로 변환할 때 새 메타데이터 하위 볼륨이 생성되고 선형 볼륨이 있는 동일한 물리 볼륨에 있는 원본 논리 볼륨과 연결됩니다. 추가 이미지는 metadata/data 하위 볼륨 쌍에 추가됩니다. 예를 들어 원본 장치가 다음과 같은 경우For example, if the original device is as follows:

# lvs -a -o name,copy_percent,devices my_vg

LV Copy% Devices

my_lv /dev/sde1(0)

2방향 RAID1 배열로 변환된 후 장치에는 다음 데이터 및 메타데이터 하위 볼륨 쌍이 포함됩니다.

#lvconvert --type raid1 -m 1 my_vg/my_lv#lvs -a -o name,copy_percent,devices my_vgLV Copy% Devices my_lv 6.25 my_lv_rimage_0(0),my_lv_rimage_1(0) [my_lv_rimage_0] /dev/sde1(0) [my_lv_rimage_1] /dev/sdf1(1) [my_lv_rmeta_0] /dev/sde1(256) [my_lv_rmeta_1] /dev/sdf1(0)

원래 논리 볼륨과 쌍을 동일한 물리 볼륨에 배치할 수 없는 메타데이터 이미지를 동일한 물리 볼륨에 배치할 수 없는 경우 lvconvert 가 실패합니다.

4.4.3.3. LVM RAID1 논리 볼륨을 LVM 선형 논리 볼륨으로 변환

-m0 인수를 지정하여 lvconvert 명령을 사용하여 기존 RAID1 LVM 논리 볼륨을 LVM 선형 논리 볼륨으로 변환할 수 있습니다. 이렇게 하면 RAID 데이터 하위 볼륨과 RAID 배열을 구성하는 모든 RAID 메타데이터 하위 볼륨이 제거되고 최상위 RAID1 이미지를 선형 논리 볼륨으로 유지합니다.

다음 예에서는 기존 LVM RAID1 논리 볼륨을 표시합니다.

# lvs -a -o name,copy_percent,devices my_vg

LV Copy% Devices

my_lv 100.00 my_lv_rimage_0(0),my_lv_rimage_1(0)

[my_lv_rimage_0] /dev/sde1(1)

[my_lv_rimage_1] /dev/sdf1(1)

[my_lv_rmeta_0] /dev/sde1(0)

[my_lv_rmeta_1] /dev/sdf1(0)

다음 명령은 LVM RAID1 논리 볼륨

my_vg/my_lv 를 LVM 선형 장치로 변환합니다.

#lvconvert -m0 my_vg/my_lv#lvs -a -o name,copy_percent,devices my_vgLV Copy% Devices my_lv /dev/sde1(1)

LVM RAID1 논리 볼륨을 LVM 선형 볼륨으로 변환할 때 제거할 물리 볼륨을 지정할 수 있습니다. 다음 예제에서는

/dev/sda1 및 /dev/sdb1 의 두 이미지로 구성된 LVM RAID1 논리 볼륨의 레이아웃을 보여줍니다. 이 예에서 lvconvert 명령은 /dev/sda1 을 제거하고 /dev/sdb1 을 선형 장치를 구성하는 물리 볼륨으로 남겨 둡니다.

#lvs -a -o name,copy_percent,devices my_vgLV Copy% Devices my_lv 100.00 my_lv_rimage_0(0),my_lv_rimage_1(0) [my_lv_rimage_0] /dev/sda1(1) [my_lv_rimage_1] /dev/sdb1(1) [my_lv_rmeta_0] /dev/sda1(0) [my_lv_rmeta_1] /dev/sdb1(0) #lvconvert -m0 my_vg/my_lv /dev/sda1#lvs -a -o name,copy_percent,devices my_vgLV Copy% Devices my_lv /dev/sdb1(1)

4.4.3.4. 미러링된 LVM 장치를 RAID1 장치로 변환

세그먼트 유형의

미러 를 사용하여 기존 미러링된 LVM 장치를 --type raid1 인수를 지정하여 lvconvert 명령을 사용하여 RAID1 LVM 장치로 변환할 수 있습니다. 미러 하위 볼륨(*_mimage_*)의 이름을 RAID 하위 볼륨(*_rimage_*)으로 변경합니다. 또한 미러 로그가 제거되고 해당 데이터 하위 볼륨과 동일한 물리 볼륨의 데이터 하위 볼륨에 대해 메타데이터 하위 볼륨(*_rmeta_*)이 생성됩니다.

다음 예제에서는 미러링된 논리 볼륨

my_vg/my_lv 의 레이아웃을 보여줍니다.

# lvs -a -o name,copy_percent,devices my_vg

LV Copy% Devices

my_lv 15.20 my_lv_mimage_0(0),my_lv_mimage_1(0)

[my_lv_mimage_0] /dev/sde1(0)

[my_lv_mimage_1] /dev/sdf1(0)

[my_lv_mlog] /dev/sdd1(0)

다음 명령은 미러링된 논리 볼륨

my_vg/my_lv 를 RAID1 논리 볼륨으로 변환합니다.

#lvconvert --type raid1 my_vg/my_lv#lvs -a -o name,copy_percent,devices my_vgLV Copy% Devices my_lv 100.00 my_lv_rimage_0(0),my_lv_rimage_1(0) [my_lv_rimage_0] /dev/sde1(0) [my_lv_rimage_1] /dev/sdf1(0) [my_lv_rmeta_0] /dev/sde1(125) [my_lv_rmeta_1] /dev/sdf1(125)

4.4.3.5. RAID 논리 볼륨 크기 조정

다음과 같은 방법으로 RAID 논리 볼륨의 크기를 조정할 수 있습니다.

- lvresize 또는 lvextend 명령을 사용하여 모든 유형의 RAID 논리 볼륨의 크기를 늘릴 수 있습니다. 이는 RAID 이미지 수를 변경하지 않습니다. 스트라이핑 RAID 논리 볼륨의 경우 스트라이프 RAID 논리 볼륨을 만들 때와 동일한 스트라이프 반올림 제약 조건이 적용됩니다. RAID 볼륨 확장에 대한 자세한 내용은 4.4.18절. “RAID 볼륨 확장” 을 참조하십시오.

- lvresize 또는 lvreduce 명령을 사용하여 모든 유형의 RAID 논리 볼륨의 크기를 줄일 수 있습니다. 이는 RAID 이미지 수를 변경하지 않습니다. lvextend 명령과 마찬가지로 스트라이프 라운드링 제약 조건은 스트라이프 RAID 논리 볼륨을 생성할 때와 동일합니다. 논리 볼륨 크기를 줄이는 명령의 예는 4.4.16절. “논리 볼륨 축소” 를 참조하십시오.

- Red Hat Enterprise Linux 7.4에서는 lvconvert 명령의

--stripes N매개변수를 사용하여 스트라이핑된 RAID 논리 볼륨(raid4/5/6/10)의 스트라이프 수를 변경할 수 있습니다. 이렇게 하면 스트라이프가 추가되거나 제거된 용량으로 RAID 논리 볼륨의 크기가 늘어나거나 줄어듭니다.raid10볼륨은 스트라이프만 추가할 수 있습니다. 이 기능은 RAID 논리 볼륨의 속성을 변경하는 동시에 동일한 RAID 수준을 유지할 수 있는 RAID reshaping 기능의 일부입니다. lvconvert 명령을 사용하여 RAID 논리 볼륨을 재구성하는 RAID 리셰이핑 및 예제에 대한 자세한 내용은 lvmraid(7) 도움말 페이지를 참조하십시오.

4.4.3.6. 기존 RAID1 장치의 이미지 수 변경

기존 RAID1 어레이의 이미지 수를 이전의 LVM 미러링 구현의 이미지 수를 변경할 수 있는 것처럼 변경할 수 있습니다. lvconvert 명령을 사용하여 추가 또는 제거할 추가 메타데이터/데이터 하위 볼륨 쌍 수를 지정합니다. 이전 LVM 미러링 구현에서 볼륨 구성을 변경하는 방법에 대한 자세한 내용은 4.4.4.4절. “미러링된 볼륨 구성 변경” 을 참조하십시오.

lvconvert 명령을 사용하여 RAID1 장치에 이미지를 추가하는 경우 결과 장치의 총 이미지 수를 지정하거나 장치에 추가할 이미지 수를 지정할 수 있습니다. 선택적으로 새 메타데이터/데이터 이미지 쌍이 있는 물리 볼륨을 지정할 수도 있습니다.

메타데이터 하위 볼륨(

*_rmeta_*)은 항상 데이터 하위 볼륨 *_rimage_*과 동일한 물리적 장치에 존재합니다. metadata/data 하위 볼륨 쌍은 RAID 배열의 다른 metadata/data 하위 볼륨 쌍과 동일한 물리 볼륨에 생성되지 않습니다(여기서 --alloc을 지정하지 않는 경우).

RAID1 볼륨에 이미지를 추가하는 명령의 형식은 다음과 같습니다.

lvconvert -m new_absolute_count vg/lv [removable_PVs] lvconvert -m +num_additional_images vg/lv [removable_PVs]

예를 들어 다음 명령은 2방향 RAID1 배열인

my_vg/my_lv 장치를 표시합니다.

# lvs -a -o name,copy_percent,devices my_vg

LV Copy% Devices

my_lv 6.25 my_lv_rimage_0(0),my_lv_rimage_1(0)

[my_lv_rimage_0] /dev/sde1(0)

[my_lv_rimage_1] /dev/sdf1(1)

[my_lv_rmeta_0] /dev/sde1(256)

[my_lv_rmeta_1] /dev/sdf1(0)

다음 명령은 2방향 RAID1 장치

my_vg/my_lv 를 3방향 RAID1 장치로 변환합니다.

#lvconvert -m 2 my_vg/my_lv#lvs -a -o name,copy_percent,devices my_vgLV Copy% Devices my_lv 6.25 my_lv_rimage_0(0),my_lv_rimage_1(0),my_lv_rimage_2(0) [my_lv_rimage_0] /dev/sde1(0) [my_lv_rimage_1] /dev/sdf1(1) [my_lv_rimage_2] /dev/sdg1(1) [my_lv_rmeta_0] /dev/sde1(256) [my_lv_rmeta_1] /dev/sdf1(0) [my_lv_rmeta_2] /dev/sdg1(0)

RAID1 배열에 이미지를 추가할 때 이미지에 사용할 물리 볼륨을 지정할 수 있습니다. 다음 명령은 2방향 RAID1 장치

my_vg/my_lv 를 3방향 RAID1 장치로 변환하여 배열에 물리 볼륨 /dev/sdd1 을 사용하도록 지정합니다.

#lvs -a -o name,copy_percent,devices my_vgLV Copy% Devices my_lv 56.00 my_lv_rimage_0(0),my_lv_rimage_1(0) [my_lv_rimage_0] /dev/sda1(1) [my_lv_rimage_1] /dev/sdb1(1) [my_lv_rmeta_0] /dev/sda1(0) [my_lv_rmeta_1] /dev/sdb1(0) #lvconvert -m 2 my_vg/my_lv /dev/sdd1#lvs -a -o name,copy_percent,devices my_vgLV Copy% Devices my_lv 28.00 my_lv_rimage_0(0),my_lv_rimage_1(0),my_lv_rimage_2(0) [my_lv_rimage_0] /dev/sda1(1) [my_lv_rimage_1] /dev/sdb1(1) [my_lv_rimage_2] /dev/sdd1(1) [my_lv_rmeta_0] /dev/sda1(0) [my_lv_rmeta_1] /dev/sdb1(0) [my_lv_rmeta_2] /dev/sdd1(0)

RAID1 배열에서 이미지를 제거하려면 다음 명령을 사용합니다. lvconvert 명령을 사용하여 RAID1 장치에서 이미지를 제거하는 경우 결과 장치의 총 이미지 수를 지정하거나 장치에서 제거할 이미지 수를 지정할 수 있습니다. 선택적으로 장치를 제거할 물리 볼륨을 지정할 수도 있습니다.

lvconvert -m new_absolute_count vg/lv [removable_PVs] lvconvert -m -num_fewer_images vg/lv [removable_PVs]

또한 이미지 및 관련 metadata 하위 볼륨이 제거되면 번호가 높은 이미지가 슬롯을 채우기 위해 축소됩니다.

lv_rimage_1 , lv_rimage_1 및 lv_rimage_ 2 로 구성된 3-way RAID1 배열에서 lv_rimage_1을 제거하면 lv_rimage_0 및 lv_rimage_1 로 구성된 RAID1 배열이 생성됩니다. 하위 볼륨 lv_rimage_2 는 이름이 변경되고 빈 슬롯을 대체하여 lv_rimage_1 이 됩니다.

다음 예제에서는 3-way RAID1 논리 볼륨

my_vg/my_lv 의 레이아웃을 보여줍니다.

# lvs -a -o name,copy_percent,devices my_vg

LV Copy% Devices

my_lv 100.00 my_lv_rimage_0(0),my_lv_rimage_1(0),my_lv_rimage_2(0)

[my_lv_rimage_0] /dev/sde1(1)

[my_lv_rimage_1] /dev/sdf1(1)

[my_lv_rimage_2] /dev/sdg1(1)

[my_lv_rmeta_0] /dev/sde1(0)

[my_lv_rmeta_1] /dev/sdf1(0)

[my_lv_rmeta_2] /dev/sdg1(0)

다음 명령은 3-way RAID1 논리 볼륨을 2way RAID1 논리 볼륨으로 변환합니다.

#lvconvert -m1 my_vg/my_lv#lvs -a -o name,copy_percent,devices my_vgLV Copy% Devices my_lv 100.00 my_lv_rimage_0(0),my_lv_rimage_1(0) [my_lv_rimage_0] /dev/sde1(1) [my_lv_rimage_1] /dev/sdf1(1) [my_lv_rmeta_0] /dev/sde1(0) [my_lv_rmeta_1] /dev/sdf1(0)

다음 명령은 3방향 RAID1 논리 볼륨을 2방향 RAID1 논리 볼륨으로 변환하여

/dev/sde1 로 제거할 이미지가 포함된 물리 볼륨을 지정합니다.

#lvconvert -m1 my_vg/my_lv /dev/sde1#lvs -a -o name,copy_percent,devices my_vgLV Copy% Devices my_lv 100.00 my_lv_rimage_0(0),my_lv_rimage_1(0) [my_lv_rimage_0] /dev/sdf1(1) [my_lv_rimage_1] /dev/sdg1(1) [my_lv_rmeta_0] /dev/sdf1(0) [my_lv_rmeta_1] /dev/sdg1(0)

4.4.3.7. RAID 이미지로부터 논리 볼륨 분리

RAID 논리 볼륨의 이미지를 분리하여 새 논리 볼륨을 형성할 수 있습니다. RAID 이미지를 분할하는 절차는 4.4.4.2절. “파티셔닝 Off aRedundant Image of a Mirrored Logical Volume” 에 설명된 대로 미러링된 논리 볼륨의 중복 이미지를 분할하는 절차와 동일합니다.

RAID 이미지를 분할하는 명령 형식은 다음과 같습니다.

lvconvert --splitmirrors count -n splitname vg/lv [removable_PVs]

기존 RAID1 논리 볼륨( 4.4.3.6절. “기존 RAID1 장치의 이미지 수 변경”에 설명된 대로)에서 RAID 이미지를 제거하는 경우와 마찬가지로 장치 중간에서 RAID 데이터 하위 볼륨(및 관련 metadata 하위 볼륨)을 제거하면 슬롯을 채우기 위해 더 높은 번호가 지정된 이미지가 축소됩니다. 따라서 RAID 배열을 구성하는 논리 볼륨의 인덱스 번호는 잘못된 정수 시퀀스입니다.

참고

RAID1 배열이 아직 동기화되지 않은 경우 RAID 이미지를 분할할 수 없습니다.

다음 예제에서는 2방향 RAID1 논리 볼륨인

my_lv 를 두 개의 선형 논리 볼륨인 my_lv 및 new 로 나눕니다.

#lvs -a -o name,copy_percent,devices my_vgLV Copy% Devices my_lv 12.00 my_lv_rimage_0(0),my_lv_rimage_1(0) [my_lv_rimage_0] /dev/sde1(1) [my_lv_rimage_1] /dev/sdf1(1) [my_lv_rmeta_0] /dev/sde1(0) [my_lv_rmeta_1] /dev/sdf1(0) #lvconvert --splitmirror 1 -n new my_vg/my_lv#lvs -a -o name,copy_percent,devices my_vgLV Copy% Devices my_lv /dev/sde1(1) new /dev/sdf1(1)

다음 예제에서는 3방향 RAID1 논리 볼륨인

my_lv 를 2방향 RAID1 논리 볼륨, my_lv 및 선형 논리 볼륨, new로 분할합니다.

#lvs -a -o name,copy_percent,devices my_vgLV Copy% Devices my_lv 100.00 my_lv_rimage_0(0),my_lv_rimage_1(0),my_lv_rimage_2(0) [my_lv_rimage_0] /dev/sde1(1) [my_lv_rimage_1] /dev/sdf1(1) [my_lv_rimage_2] /dev/sdg1(1) [my_lv_rmeta_0] /dev/sde1(0) [my_lv_rmeta_1] /dev/sdf1(0) [my_lv_rmeta_2] /dev/sdg1(0) #lvconvert --splitmirror 1 -n new my_vg/my_lv#lvs -a -o name,copy_percent,devices my_vgLV Copy% Devices my_lv 100.00 my_lv_rimage_0(0),my_lv_rimage_1(0) [my_lv_rimage_0] /dev/sde1(1) [my_lv_rimage_1] /dev/sdf1(1) [my_lv_rmeta_0] /dev/sde1(0) [my_lv_rmeta_1] /dev/sdf1(0) new /dev/sdg1(1)

4.4.3.8. RAID 이미지 분할 및 병합

lvconvert 명령의

--splitmirrors 인수와 함께 --trackchanges 인수를 사용하여 변경 사항을 추적하는 동안 읽기 전용 사용을 위해 RAID1 배열의 이미지를 일시적으로 분할할 수 있습니다. 이렇게 하면 이미지를 나중에 배열에 다시 병합하고 이미지가 분할된 이후 변경된 배열의 부분만 다시 동기화할 수 있습니다.

RAID 이미지를 분할하는 lvconvert 명령의 형식은 다음과 같습니다.

lvconvert --splitmirrors count --trackchanges vg/lv [removable_PVs]

--trackchanges 인수를 사용하여 RAID 이미지를 분할하면 분할할 이미지를 지정할 수 있지만 분할할 볼륨 이름은 변경할 수 없습니다. 또한 결과 볼륨에는 다음과 같은 제약 조건이 있습니다.

- 만든 새 볼륨은 읽기 전용입니다.

- 새 볼륨의 크기를 조정할 수 없습니다.

- 나머지 배열의 이름을 변경할 수 없습니다.

- 나머지 배열은 조정할 수 없습니다.

- 새 볼륨과 나머지 배열을 독립적으로 활성화할 수 있습니다.

--merge 인수와 함께 후속 lvconvert 명령을 실행하여 지정된

--trackchanges 인수와 함께 분할된 이미지를 병합할 수 있습니다. 이미지를 병합할 때 이미지가 분할된 이후 변경된 배열의 부분만 다시 동기화됩니다.

RAID 이미지를 병합하는 lvconvert 명령의 형식은 다음과 같습니다.

lvconvert --merge raid_image

다음 예제에서는 RAID1 논리 볼륨을 생성한 다음 나머지 배열로 변경 사항을 추적하면서 해당 볼륨에서 이미지를 분할합니다.

#lvcreate --type raid1 -m 2 -L 1G -n my_lv .vgLogical volume "my_lv" created #lvs -a -o name,copy_percent,devices my_vgLV Copy% Devices my_lv 100.00 my_lv_rimage_0(0),my_lv_rimage_1(0),my_lv_rimage_2(0) [my_lv_rimage_0] /dev/sdb1(1) [my_lv_rimage_1] /dev/sdc1(1) [my_lv_rimage_2] /dev/sdd1(1) [my_lv_rmeta_0] /dev/sdb1(0) [my_lv_rmeta_1] /dev/sdc1(0) [my_lv_rmeta_2] /dev/sdd1(0) #lvconvert --splitmirrors 1 --trackchanges my_vg/my_lvmy_lv_rimage_2 split from my_lv for read-only purposes. Use 'lvconvert --merge my_vg/my_lv_rimage_2' to merge back into my_lv #lvs -a -o name,copy_percent,devices my_vgLV Copy% Devices my_lv 100.00 my_lv_rimage_0(0),my_lv_rimage_1(0),my_lv_rimage_2(0) [my_lv_rimage_0] /dev/sdb1(1) [my_lv_rimage_1] /dev/sdc1(1) my_lv_rimage_2 /dev/sdd1(1) [my_lv_rmeta_0] /dev/sdb1(0) [my_lv_rmeta_1] /dev/sdc1(0) [my_lv_rmeta_2] /dev/sdd1(0)

다음 예제에서는 RAID1 볼륨에서 이미지를 분할하고 나머지 배열에 변경 사항을 추적한 다음 볼륨을 다시 배열에 병합합니다.

#lvconvert --splitmirrors 1 --trackchanges my_vg/my_lvlv_rimage_1 split from my_lv for read-only purposes. Use 'lvconvert --merge my_vg/my_lv_rimage_1' to merge back into my_lv #lvs -a -o name,copy_percent,devices my_vgLV Copy% Devices my_lv 100.00 my_lv_rimage_0(0),my_lv_rimage_1(0) [my_lv_rimage_0] /dev/sdc1(1) my_lv_rimage_1 /dev/sdd1(1) [my_lv_rmeta_0] /dev/sdc1(0) [my_lv_rmeta_1] /dev/sdd1(0) #lvconvert --merge my_vg/my_lv_rimage_1my_vg/my_lv_rimage_1 successfully merged back into my_vg/my_lv #lvs -a -o name,copy_percent,devices my_vgLV Copy% Devices my_lv 100.00 my_lv_rimage_0(0),my_lv_rimage_1(0) [my_lv_rimage_0] /dev/sdc1(1) [my_lv_rimage_1] /dev/sdd1(1) [my_lv_rmeta_0] /dev/sdc1(0) [my_lv_rmeta_1] /dev/sdd1(0)

RAID1 볼륨에서 이미지를 분할한 후에는 두 번째 lvconvert --splitmirrors 명령을 실행하여

--trackchanges 인수를 지정하지 않고 이미지를 분할하는 초기 lvconvert 명령을 반복하여 분할을 영구적으로 만들 수 있습니다. 이렇게 하면 --trackchanges 인수가 생성된 링크가 중단됩니다.

--trackchanges 인수로 이미지를 분할한 후에는 추적 중인 이미지를 영구적으로 분할하지 않으려면 해당 배열에서 후속 lvconvert --splitmirrors 명령을 실행할 수 없습니다.

다음 명령 시퀀스는 이미지를 분할하고 이미지를 추적한 다음 추적 중인 이미지를 영구적으로 분할합니다.

#lvconvert --splitmirrors 1 --trackchanges my_vg/my_lvmy_lv_rimage_1 split from my_lv for read-only purposes. Use 'lvconvert --merge my_vg/my_lv_rimage_1' to merge back into my_lv #lvconvert --splitmirrors 1 -n new my_vg/my_lv#lvs -a -o name,copy_percent,devices my_vgLV Copy% Devices my_lv /dev/sdc1(1) new /dev/sdd1(1)

그러나 다음 명령 시퀀스는 실패합니다.

#lvconvert --splitmirrors 1 --trackchanges my_vg/my_lvmy_lv_rimage_1 split from my_lv for read-only purposes. Use 'lvconvert --merge my_vg/my_lv_rimage_1' to merge back into my_lv #lvconvert --splitmirrors 1 --trackchanges my_vg/my_lvCannot track more than one split image at a time

마찬가지로 분할 이미지가 추적 중인 이미지가 아니므로 다음 명령 순서도 실패합니다.

#lvconvert --splitmirrors 1 --trackchanges my_vg/my_lvmy_lv_rimage_1 split from my_lv for read-only purposes. Use 'lvconvert --merge my_vg/my_lv_rimage_1' to merge back into my_lv #lvs -a -o name,copy_percent,devices my_vgLV Copy% Devices my_lv 100.00 my_lv_rimage_0(0),my_lv_rimage_1(0) [my_lv_rimage_0] /dev/sdc1(1) my_lv_rimage_1 /dev/sdd1(1) [my_lv_rmeta_0] /dev/sdc1(0) [my_lv_rmeta_1] /dev/sdd1(0) #lvconvert --splitmirrors 1 -n new my_vg/my_lv /dev/sdc1Unable to split additional image from my_lv while tracking changes for my_lv_rimage_1

4.4.3.9. RAID 오류 정책 설정

LVM RAID는

lvm.conf 파일의 raid_fault_policy 필드에 정의된 기본 설정에 따라 장치 오류를 자동으로 처리합니다.

raid_fault_policy필드가allocate로 설정된 경우 시스템은 볼륨 그룹의 예비 장치로 실패한 장치를 대체하려고 합니다. 사용 가능한 예비 장치가 없으면 시스템 로그에 보고됩니다.raid_fault_policy필드가warn로 설정된 경우 시스템은 경고를 생성하고 로그는 장치가 실패했음을 나타냅니다. 이를 통해 사용자는 수행할 작업 과정을 결정할 수 있습니다.

사용성을 지원하기에 충분한 장치가 남아 있는 경우 RAID 논리 볼륨이 계속 작동합니다.

4.4.3.9.1. RAID Fault 정책 할당

다음 예에서

raid_fault_policy 필드가 lvm.conf 파일에 할당 하도록 설정되어 있습니다. RAID 논리 볼륨은 다음과 같이 표시됩니다.

# lvs -a -o name,copy_percent,devices my_vg

LV Copy% Devices

my_lv 100.00 my_lv_rimage_0(0),my_lv_rimage_1(0),my_lv_rimage_2(0)

[my_lv_rimage_0] /dev/sde1(1)

[my_lv_rimage_1] /dev/sdf1(1)

[my_lv_rimage_2] /dev/sdg1(1)

[my_lv_rmeta_0] /dev/sde1(0)

[my_lv_rmeta_1] /dev/sdf1(0)

[my_lv_rmeta_2] /dev/sdg1(0)

/dev/sde 장치가 실패하면 시스템 로그에 오류 메시지가 표시됩니다.

# grep lvm /var/log/messages

Jan 17 15:57:18 bp-01 lvm[8599]: Device #0 of raid1 array, my_vg-my_lv, has failed.

Jan 17 15:57:18 bp-01 lvm[8599]: /dev/sde1: read failed after 0 of 2048 at

250994294784: Input/output error

Jan 17 15:57:18 bp-01 lvm[8599]: /dev/sde1: read failed after 0 of 2048 at

250994376704: Input/output error

Jan 17 15:57:18 bp-01 lvm[8599]: /dev/sde1: read failed after 0 of 2048 at 0:

Input/output error

Jan 17 15:57:18 bp-01 lvm[8599]: /dev/sde1: read failed after 0 of 2048 at

4096: Input/output error

Jan 17 15:57:19 bp-01 lvm[8599]: Couldn't find device with uuid

3lugiV-3eSP-AFAR-sdrP-H20O-wM2M-qdMANy.

Jan 17 15:57:27 bp-01 lvm[8599]: raid1 array, my_vg-my_lv, is not in-sync.

Jan 17 15:57:36 bp-01 lvm[8599]: raid1 array, my_vg-my_lv, is now in-sync.

raid_fault_policy 필드가 allocate 로 설정되었으므로 실패한 장치가 볼륨 그룹의 새 장치로 교체됩니다.

# lvs -a -o name,copy_percent,devices vg

Couldn't find device with uuid 3lugiV-3eSP-AFAR-sdrP-H20O-wM2M-qdMANy.

LV Copy% Devices

lv 100.00 lv_rimage_0(0),lv_rimage_1(0),lv_rimage_2(0)

[lv_rimage_0] /dev/sdh1(1)

[lv_rimage_1] /dev/sdf1(1)

[lv_rimage_2] /dev/sdg1(1)

[lv_rmeta_0] /dev/sdh1(0)

[lv_rmeta_1] /dev/sdf1(0)

[lv_rmeta_2] /dev/sdg1(0)

실패한 장치를 교체했지만 디스플레이는 LVM에서 실패한 장치를 찾을 수 없음을 나타냅니다. 이는 실패한 장치가 RAID 논리 볼륨에서 제거되었지만 아직 실패한 장치가 볼륨 그룹에서 제거되지 않았기 때문입니다. 볼륨 그룹에서 실패한 장치를 제거하려면 Cryostatreduce --removemissing VG를 실행할 수 있습니다.

raid_fault_policy 를 allocate 로 설정했지만 예비 장치가 없는 경우 할당이 실패하고 논리 볼륨을 그대로 둡니다. 할당이 실패하면 드라이브를 수정한 다음 논리 볼륨을 비활성화 및 활성화하는 옵션이 있습니다. 이는 4.4.3.9.2절. “warn RAID Fault Policy” 에 설명되어 있습니다. 또는 4.4.3.10절. “RAID 장치 교체” 에 설명된 대로 실패한 장치를 교체할 수 있습니다.

4.4.3.9.2. warn RAID Fault Policy

다음 예에서

raid_fault_policy 필드가 lvm.conf 파일에서 warn 로 설정되어 있습니다. RAID 논리 볼륨은 다음과 같이 표시됩니다.

# lvs -a -o name,copy_percent,devices my_vg

LV Copy% Devices

my_lv 100.00 my_lv_rimage_0(0),my_lv_rimage_1(0),my_lv_rimage_2(0)

[my_lv_rimage_0] /dev/sdh1(1)

[my_lv_rimage_1] /dev/sdf1(1)

[my_lv_rimage_2] /dev/sdg1(1)

[my_lv_rmeta_0] /dev/sdh1(0)

[my_lv_rmeta_1] /dev/sdf1(0)

[my_lv_rmeta_2] /dev/sdg1(0)

/dev/sdh 장치가 실패하면 시스템 로그에 오류 메시지가 표시됩니다. 그러나 이 경우 LVM에서 이미지 중 하나를 교체하여 RAID 장치를 자동으로 복구하지 않습니다. 대신 장치가 실패한 경우 다음과 같이 장치를 lvconvert 명령의 --repair 인수로 교체할 수 있습니다.

#lvconvert --repair my_vg/my_lv/dev/sdh1: read failed after 0 of 2048 at 250994294784: Input/output error /dev/sdh1: read failed after 0 of 2048 at 250994376704: Input/output error /dev/sdh1: read failed after 0 of 2048 at 0: Input/output error /dev/sdh1: read failed after 0 of 2048 at 4096: Input/output error Couldn't find device with uuid fbI0YO-GX7x-firU-Vy5o-vzwx-vAKZ-feRxfF. Attempt to replace failed RAID images (requires full device resync)? [y/n]:y#lvs -a -o name,copy_percent,devices my_vgCouldn't find device with uuid fbI0YO-GX7x-firU-Vy5o-vzwx-vAKZ-feRxfF. LV Copy% Devices my_lv 64.00 my_lv_rimage_0(0),my_lv_rimage_1(0),my_lv_rimage_2(0) [my_lv_rimage_0] /dev/sde1(1) [my_lv_rimage_1] /dev/sdf1(1) [my_lv_rimage_2] /dev/sdg1(1) [my_lv_rmeta_0] /dev/sde1(0) [my_lv_rmeta_1] /dev/sdf1(0) [my_lv_rmeta_2] /dev/sdg1(0)

실패한 장치를 교체했지만 디스플레이는 LVM에서 실패한 장치를 찾을 수 없음을 나타냅니다. 이는 실패한 장치가 RAID 논리 볼륨에서 제거되었지만 아직 실패한 장치가 볼륨 그룹에서 제거되지 않았기 때문입니다. 볼륨 그룹에서 실패한 장치를 제거하려면 Cryostatreduce --removemissing VG를 실행할 수 있습니다.

장치 오류가 일시적인 오류이거나 실패한 장치를 복구할 수 있는 경우 lvchange 명령의

--refresh 옵션을 사용하여 실패한 장치의 복구를 시작할 수 있습니다. 이전에는 논리 볼륨을 비활성화한 다음 활성화해야 했습니다.

다음 명령은 논리 볼륨을 새로 고칩니다.

# lvchange --refresh my_vg/my_lv4.4.3.10. RAID 장치 교체

RAID는 기존 LVM 미러링과 같지 않습니다. LVM 미러링을 제거하려면 실패한 장치를 제거하거나 미러링된 논리 볼륨이 중단되었습니다. RAID 배열은 실패한 장치로 계속 실행될 수 있습니다. 실제로 RAID1 이외의 RAID 유형의 경우 장치를 제거하는 것은 더 낮은 수준의 RAID(예: RAID6에서 RAID5로 또는 RAID4 또는 RAID5에서 RAID0)로 변환하는 것을 의미합니다. 따라서 실패한 장치를 무조건 제거하고 대체를 잠재적으로 할당하는 대신 LVM을 사용하면 lvconvert 명령의

--replace 인수를 사용하여 1단계 솔루션의 RAID 볼륨의 장치를 교체할 수 있습니다.

lvconvert --replace 의 형식은 다음과 같습니다.

lvconvert --replace dev_to_remove vg/lv [possible_replacements]

다음 예제에서는 RAID1 논리 볼륨을 생성한 다음 해당 볼륨에서 장치를 교체합니다.

#lvcreate --type raid1 -m 2 -L 1G -n my_lv my_vgLogical volume "my_lv" created #lvs -a -o name,copy_percent,devices my_vgLV Copy% Devices my_lv 100.00 my_lv_rimage_0(0),my_lv_rimage_1(0),my_lv_rimage_2(0) [my_lv_rimage_0] /dev/sdb1(1) [my_lv_rimage_1] /dev/sdb2(1) [my_lv_rimage_2] /dev/sdc1(1) [my_lv_rmeta_0] /dev/sdb1(0) [my_lv_rmeta_1] /dev/sdb2(0) [my_lv_rmeta_2] /dev/sdc1(0) #lvconvert --replace /dev/sdb2 my_vg/my_lv#lvs -a -o name,copy_percent,devices my_vgLV Copy% Devices my_lv 37.50 my_lv_rimage_0(0),my_lv_rimage_1(0),my_lv_rimage_2(0) [my_lv_rimage_0] /dev/sdb1(1) [my_lv_rimage_1] /dev/sdc2(1) [my_lv_rimage_2] /dev/sdc1(1) [my_lv_rmeta_0] /dev/sdb1(0) [my_lv_rmeta_1] /dev/sdc2(0) [my_lv_rmeta_2] /dev/sdc1(0)

다음 예제에서는 RAID1 논리 볼륨을 생성한 다음 해당 볼륨에서 장치를 교체하는데 사용할 물리 볼륨을 지정합니다.

#lvcreate --type raid1 -m 1 -L 100 -n my_lv my_vgLogical volume "my_lv" created #lvs -a -o name,copy_percent,devices my_vgLV Copy% Devices my_lv 100.00 my_lv_rimage_0(0),my_lv_rimage_1(0) [my_lv_rimage_0] /dev/sda1(1) [my_lv_rimage_1] /dev/sdb1(1) [my_lv_rmeta_0] /dev/sda1(0) [my_lv_rmeta_1] /dev/sdb1(0) #pvsPV VG Fmt Attr PSize PFree /dev/sda1 my_vg lvm2 a-- 1020.00m 916.00m /dev/sdb1 my_vg lvm2 a-- 1020.00m 916.00m /dev/sdc1 my_vg lvm2 a-- 1020.00m 1020.00m /dev/sdd1 my_vg lvm2 a-- 1020.00m 1020.00m #lvconvert --replace /dev/sdb1 my_vg/my_lv /dev/sdd1#lvs -a -o name,copy_percent,devices my_vgLV Copy% Devices my_lv 28.00 my_lv_rimage_0(0),my_lv_rimage_1(0) [my_lv_rimage_0] /dev/sda1(1) [my_lv_rimage_1] /dev/sdd1(1) [my_lv_rmeta_0] /dev/sda1(0) [my_lv_rmeta_1] /dev/sdd1(0)

다음 예와 같이 여러 대체 인수를 지정하여 한 번에 두 개 이상의 RAID 장치를

교체할 수 있습니다.

#lvcreate --type raid1 -m 2 -L 100 -n my_lv my_vgLogical volume "my_lv" created #lvs -a -o name,copy_percent,devices my_vgLV Copy% Devices my_lv 100.00 my_lv_rimage_0(0),my_lv_rimage_1(0),my_lv_rimage_2(0) [my_lv_rimage_0] /dev/sda1(1) [my_lv_rimage_1] /dev/sdb1(1) [my_lv_rimage_2] /dev/sdc1(1) [my_lv_rmeta_0] /dev/sda1(0) [my_lv_rmeta_1] /dev/sdb1(0) [my_lv_rmeta_2] /dev/sdc1(0) #lvconvert --replace /dev/sdb1 --replace /dev/sdc1 my_vg/my_lv#lvs -a -o name,copy_percent,devices my_vgLV Copy% Devices my_lv 60.00 my_lv_rimage_0(0),my_lv_rimage_1(0),my_lv_rimage_2(0) [my_lv_rimage_0] /dev/sda1(1) [my_lv_rimage_1] /dev/sdd1(1) [my_lv_rimage_2] /dev/sde1(1) [my_lv_rmeta_0] /dev/sda1(0) [my_lv_rmeta_1] /dev/sdd1(0) [my_lv_rmeta_2] /dev/sde1(0)

참고

lvconvert --replace 명령을 사용하여 교체 드라이브를 지정하면 배열에 이미 사용된 드라이브의 추가 공간에서 교체 드라이브를 할당해서는 안 됩니다. 예를 들어

lv_rimage_0 및 lv_rimage_1 은 동일한 물리 볼륨에 있으면 안 됩니다.

4.4.3.11. RAID 논리 볼륨 삭제

LVM은 RAID 논리 볼륨에 대한 스크럽 지원을 제공합니다. RAID 스크럽은 배열에서 모든 데이터 및 패리티 블록을 읽고 해당 블록이 일관된지 여부를 확인하는 프로세스입니다.

lvchange 명령의

--syncaction 옵션을 사용하여 RAID 스크럽 작업을 시작합니다. 검사 또는 복구 작업을 지정합니다. 검사 작업은 배열을 통과하여 배열의 불일치 수를 기록하지만 복구하지는 않습니다. 복구 작업은 찾기에 따라 불일치를 수정합니다.

RAID 논리 볼륨을 스크럽하는 명령 형식은 다음과 같습니다.

lvchange --syncaction {check|repair} vg/raid_lv참고

lvchange --syncaction repair Cryostat /raid_lv 작업은 lv convert --repair Cryostat /raid_lv 작업과 동일한 기능을 수행하지 않습니다. lvchange --syncaction 복구 작업은 배열에서 백그라운드 동기화 작업을 시작합니다. lvconvert --repair 작업은 미러 또는 RAID 논리 볼륨에서 실패한 장치를 복구/수정하도록 설계되었습니다.

새로운 RAID scrubbing 작업을 지원하기 위해 lvs 명령은 이제

raid_sync_action 및 raid_mismatch_count 라는 두 개의 새 출력 가능한 필드를 지원합니다. 이러한 필드는 기본적으로 인쇄되지 않습니다. 이러한 필드를 표시하려면 다음과 같이 lv의 -o 매개변수를 사용하여 지정합니다.

lvs -o +raid_sync_action,raid_mismatch_count vg/lv

raid_sync_action 필드에는 raid 볼륨이 수행 중인 현재 동기화 작업이 표시됩니다. 다음 값 중 하나일 수 있습니다.

idle: 모든 동기화 작업이 완료 (없음)Resync: 배열 초기화 또는 시스템 오류 후 복구- Replacing a device in the array

check: array inconsistencies 검색복구: 불일치를 찾고 복구

raid_mismatch_count 필드에는 검사 작업 중 발견된 불일치 수가 표시됩니다.

이제 lvs 명령의

Cpy%Sync 필드가 검사 및 복구를 포함하여 raid_sync_action 작업 진행 상황을 출력합니다.

lvs 명령 출력의

lv_attr 필드에는 RAID 스크러빙 작업을 지원하기 위한 추가 표시기가 제공됩니다. 이 필드의 비트 9는 논리 볼륨의 상태를 표시하며 이제 다음 지표를 지원합니다.

- (m)ismatches는 RAID 논리 볼륨에 불일치가 있음을 나타냅니다. 이 문자는 스크럽 작업이 RAID의 일부가 일관되지 않은 부분을 감지한 후에 표시됩니다.

- (R)efresh는 RAID 배열의 장치가 오류가 발생했음을 나타내며, 커널은 LVM이 장치 레이블을 읽고 장치를 작동할 것으로 간주하더라도 실패한 것으로 간주합니다. 논리 볼륨은 장치를 현재 사용할 수 있음을 알리는 (r)efreshed이거나 실패한 것으로 의심되는 경우 장치를 (r) 배치해야 합니다.

lvs 명령에 대한 자세한 내용은 4.8.2절. “오브젝트 표시 필드” 을 참조하십시오.

RAID 스크러블링 작업을 수행할 때

동기화 작업에 필요한 백그라운드 I/O는 볼륨 그룹 메타데이터 업데이트 등 LVM 장치에 대한 다른 I/O 작업을 크라우드할 수 있습니다. 이로 인해 다른 LVM 작업이 느려질 수 있습니다. 복구 제한 사항을 구현하여 RAID 논리 볼륨이 스크럽되는 속도를 제어할 수 있습니다.

lvchange 명령의

--minrecoveryrate 및 --maxrecoveryrate 옵션을 사용하여 해당 작업의 최소 및 최대 I/O 속도를 설정하여 동기화 작업이 수행되는 속도를 제어합니다. 이러한 옵션을 다음과 같이 지정합니다.

--maxrecoveryrate 속도[bBsSkKmMgG]RAID 논리 볼륨의 최대 복구 속도를 설정하여 nominal I/O 작업을 대규모로 설정하지 않도록 합니다. Rate 는 배열의 각 장치에 대한 초당 양으로 지정됩니다. 접미사가 제공되지 않으면 kiB/sec/device로 가정합니다. 복구 속도를 0으로 설정하면 바인딩되지 않음을 의미합니다.--minrecoveryrate 속도[bBsSkKmMgG]RAID 논리 볼륨의 최소 복구 속도를 설정하여동기화작업의 I/O가 무분별 I/O가 있는 경우에도 최소 처리량을 확보합니다. Rate 는 배열의 각 장치에 대한 초당 양으로 지정됩니다. 접미사가 제공되지 않으면 kiB/sec/device로 가정합니다.

4.4.3.12. RAID takeover(Red Hat Enterprise Linux 7.4 및 later)

LVM은 Raid takeover 를 지원하므로 RAID 논리 볼륨을 한 RAID 수준에서 다른 단계로 변환합니다(예: RAID 5에서 RAID 6으로). RAID 수준 변경은 일반적으로 장치 오류 또는 나머지 논리 볼륨에 대한 복원성을 늘리거나 줄이기 위해 수행됩니다. RAID takeover에 lvconvert 를 사용합니다. RAID에 대한 정보와 lvconvert 를 사용하여 RAID 논리 볼륨을 변환하는 예제는 lvmraid(7) 매뉴얼 페이지를 참조하십시오.

4.4.3.13. RAID 논리 볼륨 조정(Red Hat Enterprise Linux 7.4 및 later)

RAID reshaping 은 동일한 RAID 수준을 유지하면서 RAID 논리 볼륨의 속성을 변경한다는 것을 의미합니다. 변경할 수 있는 일부 속성에는 RAID 레이아웃, 스트라이프 크기 및 스트라이프 수가 포함됩니다. lvconvert 명령을 사용하여 RAID 논리 볼륨을 재구성하는 RAID 리셰이핑 및 예제에 대한 자세한 내용은 lvmraid(7) 도움말 페이지를 참조하십시오.

4.4.3.14. RAID1 논리 볼륨에서 I/O 작업 제어

lvchange 명령의 --writemost 및

--write behind 매개변수를 사용하여 RAID1 논리 볼륨에서 장치의 I/O 작업을 제어할 수 있습니다. 이러한 매개 변수를 사용하는 형식은 다음과 같습니다.

--[raid]writemostly PhysicalVolume[:{t|y|n}]RAID1 논리 볼륨의 장치를대부분 쓰기로표시합니다. 이러한 드라이브에 대한 모든 읽기는 필요하지 않은 한 피할 수 있습니다. 이 매개 변수를 설정하면 I/O 작업 수를 드라이브에 최소로 유지합니다. 기본적으로write-mostly속성은 논리 볼륨에서 지정된 물리 볼륨에 대해 yes로 설정됩니다. 물리 볼륨에:n을 추가하거나:t를 지정하여 값을 전환하여write-mostly플래그를 제거할 수 있습니다.--writemostly인수는 단일 명령에서 두 번 이상 지정할 수 있으므로 논리 볼륨의 모든 물리 볼륨에 대해 가장 쓰기 특성을 한 번에 전환할 수 있습니다.--[RAID]writebehind IOCount가장 많이 쓰기로 표시된 RAID1 논리 볼륨의 장치에 허용되는 미해결쓰기의 최대 수를 지정합니다. 이 값을 초과하면 쓰기가 동기가 되어 배열이 쓰기가 완료되기 전에 구성 장치에 대한 모든 쓰기가 완료됩니다. 값을 0으로 설정하면 기본 설정이 지워지고 시스템에서 임의로 값을 선택할 수 있습니다.

4.4.3.15. RAID 논리 볼륨(Red Hat Enterprise Linux 7.4 이상)에서 지역 크기 변경

RAID 논리 볼륨을 생성할 때 논리 볼륨의 영역 크기는

/etc/lvm/lvm.conf 파일의 raid_region_size 매개변수 값이 됩니다. 이 기본값을 lvcreate 명령의 -R 옵션으로 덮어쓸 수 있습니다.

RAID 논리 볼륨을 생성한 후에는 lvconvert 명령의

-R 옵션을 사용하여 볼륨의 영역 크기를 변경할 수 있습니다. 다음 예제에서는 논리 볼륨 Cryostat /raidlv 의 지역 크기를 4096K로 변경합니다. 영역 크기를 변경하려면 RAID 볼륨을 동기화해야 합니다.

#lvconvert -R 4096K vg/raid1Do you really want to change the region_size 512.00 KiB of LV vg/raid1 to 4.00 MiB? [y/n]:yChanged region size on RAID LV vg/raid1 to 4.00 MiB.

4.4.4. 미러링된 볼륨 생성

Red Hat Enterprise Linux 7.0 릴리스의 경우 LVM은 4.4.3절. “RAID 논리 볼륨” 에 설명된 대로 RAID 1/4/5/6/10을 지원합니다. RAID 논리 볼륨은 클러스터가 인식되지 않습니다. RAID 논리 볼륨은 한 컴퓨터에서만 생성하고 활성화할 수 있지만 두 개 이상의 컴퓨터에서 동시에 활성화할 수 없습니다. 비독점 미러링 볼륨이 필요한 경우 이 섹션에 설명된 대로

미러 세그먼트 유형으로 볼륨을 생성해야 합니다.

참고

미러 의 세그먼트 유형으로 기존 LVM 장치를 RAID1 LVM 장치로 변환하는 방법에 대한 자세한 내용은 4.4.3.4절. “미러링된 LVM 장치를 RAID1 장치로 변환” 을 참조하십시오.

참고

클러스터에 미러링된 LVM 논리 볼륨을 생성하려면 단일 노드에서

미러 세그먼트 유형으로 미러링된 LVM 논리 볼륨을 생성하는 것과 동일한 명령 및 절차가 필요합니다. 그러나 클러스터에 미러링된 LVM 볼륨을 생성하려면 클러스터 및 클러스터 미러 인프라를 실행해야 하며 클러스터가 정족수화되어야 하며 lvm.conf 파일의 잠금 유형을 클러스터 잠금을 활성화하려면 올바르게 설정해야 합니다. 클러스터에 미러링된 볼륨을 생성하는 예는 5.5절. “클러스터에서 미러링된 LVM 논리 볼륨 생성” 를 참조하십시오.

클러스터의 여러 노드에서 빠르게 연속으로 여러 LVM 미러 생성 및 변환 명령을 실행하려고 하면 이러한 명령이 백포트될 수 있습니다. 이로 인해 요청된 일부 작업이 시간 초과되고 이후에 실패할 수 있습니다. 이 문제를 방지하려면 클러스터의 한 노드에서 클러스터 미러 생성 명령을 실행하는 것이 좋습니다.

미러링된 볼륨을 생성할 때 lvcreate 명령의

-m 인수를 사용하여 만들 데이터의 사본 수를 지정합니다. m1 을 지정하면 하나의 미러가 생성되며 파일 시스템의 두 복사본(lineline 논리 볼륨과 하나의 복사)을 생성합니다. 마찬가지로 -m2 를 지정하면 미러 두 개가 생성되어 파일 시스템의 복사본 3개가 생성됩니다.

다음 명령은 단일 미러를 사용하여 미러링된 논리 볼륨을 생성합니다. 볼륨은 크기가 50 기가바이트이며

mirrorlv 이며 볼륨 그룹>.< 0:에서 제거됩니다.

# lvcreate --type mirror -L 50G -m 1 -n mirrorlv vg0

LVM 미러는 복사 중인 장치를 기본적으로 512KB의 크기로 나눕니다. lvcreate 명령의

-R 인수를 사용하여 지역 크기를 메가바이트로 지정할 수 있습니다. lvm.conf 파일에서 mirror_region_size 설정을 편집하여 기본 영역 크기를 변경할 수도 있습니다.

참고

클러스터 인프라의 제한으로 인해 1.5TB보다 큰 클러스터 미러를 512KB의 기본 리전 크기로 생성할 수 없습니다. 더 큰 미러가 필요한 사용자는 지역 크기를 기본에서 더 큰 값으로 늘려야 합니다. 영역 크기를 늘리지 않으면 LVM 생성이 중단되고 다른 LVM 명령도 중단될 수 있습니다.

1.5TB보다 큰 미러의 영역 크기를 지정하기 위한 일반적인 지침으로 테라바이트에서 미러 크기를 가져와서 lvcreate 명령에

-R 인수로 사용하여 해당 수를 다음 2의 값으로 반올림할 수 있습니다. 예를 들어 미러 크기가 1.5TB인 경우 -R 2 를 지정할 수 있습니다. 미러 크기가 3TB인 경우 -R 4 를 지정할 수 있습니다. 미러 크기가 5TB인 경우 -R 8 을 지정할 수 있습니다.

다음 명령은 영역 크기가 2MB인 미러링된 논리 볼륨을 생성합니다.

# lvcreate --type mirror -m 1 -L 2T -R 2 -n mirror vol_group

미러가 생성되면 미러 지역이 동기화됩니다. 대규모 미러 구성 요소의 경우 동기화 프로세스에 시간이 오래 걸릴 수 있습니다. 다시 시작할 필요가 없는 새 미러를 만드는 경우

--nosync 인수를 지정하여 첫 번째 장치의 초기 동기화가 필요하지 않음을 나타낼 수 있습니다.

LVM은 미러 또는 미러와 동기화되는 영역을 추적하는 데 사용하는 작은 로그를 유지 관리합니다. 기본적으로 이 로그는 디스크에 유지되므로 재부팅 후에도 영구적으로 유지되며 시스템이 재부팅되거나 충돌할 때마다 미러를 다시 동기화할 필요가 없습니다. 대신 이 로그가

--mirrorlog core 인수를 사용하여 메모리에 보관하도록 지정할 수 있습니다. 따라서 추가 로그 장치에 대한 필요성을 제거하지만 전체 미러를 재부팅할 때마다 다시 동기화해야 합니다.

다음 명령은 볼륨 그룹

bigvg 에서 미러링된 논리 볼륨을 생성합니다. 논리 볼륨의 이름은 ondiskmirvol 이며 단일 미러가 있습니다. 볼륨은 크기가 12MB이며 미러 로그를 메모리에 유지합니다.

# lvcreate --type mirror -L 12MB -m 1 --mirrorlog core -n ondiskmirvol bigvg

Logical volume "ondiskmirvol" created

미러 로그는 미러 복사본이 생성되는 장치와 별도의 장치에 생성됩니다. 그러나

--alloc을 사용하여 mirror leg 중 하나와 동일한 장치에 미러 로그를 생성할 수 있습니다. 이로 인해 성능이 저하될 수 있지만 두 개의 기본 장치만 있어도 미러를 만들 수 있습니다.

다음 명령은 미러 로그가 미러 로그 중 하나와 동일한 장치에 미러 로그가 단일 미러인 미러링된 논리 볼륨을 생성합니다. 이 예에서 볼륨 그룹은

두 개의 장치로만 구성됩니다. 이 명령은 Cryostat 0 볼륨 그룹에 mirrorlv 라는 500MB 볼륨을 생성합니다.

# lvcreate --type mirror -L 500M -m 1 -n mirrorlv -alloc anywhere vg0참고

클러스터형 미러를 사용하는 경우 미러 로그 관리는 현재 클러스터 ID가 가장 낮은 클러스터 노드를 전적으로 담당합니다. 따라서 클러스터 미러 로그를 보유한 장치를 클러스터의 하위 집합에서 사용할 수 없게 되면 ID가 가장 낮은 클러스터 노드가 미러 로그에 액세스할 수 있는 경우 클러스터형 미러가 아무런 영향 없이 계속 작동할 수 있습니다. 미러는disturbed이므로 자동 수정 작업(repair)도 발행되지 않습니다. lowest-ID 클러스터 노드가 미러 로그에 대한 액세스 권한을 잃으면 자동 작업이 시작됩니다(다른 노드에서 로그에 대한 액세스 가능성은 아님).

미러링된 미러 로그를 생성하려면

--mirrorlog 미러링 된 인수를 지정할 수 있습니다. 다음 명령은 볼륨 그룹 bigvg 에서 미러링된 논리 볼륨을 생성합니다. 논리 볼륨의 이름은 twologvol 이며 단일 미러가 있습니다. 볼륨은 크기가 12MB이고 미러 로그는 각 로그가 별도의 장치에 보관되어 있습니다.

# lvcreate --type mirror -L 12MB -m 1 --mirrorlog mirrored -n twologvol bigvg

Logical volume "twologvol" created

표준 미러 로그와 마찬가지로 Cryostatcreate 명령의

임의의 인수를 사용하여 --alloc 을 사용하여 미러 브릿지와 동일한 장치에서 중복 미러 로그를 생성할 수 있습니다. 이로 인해 성능이 저하될 수 있지만 각 로그가 미러 다리보다 별도의 장치에 보관될 수 있는 충분한 기본 장치가 없는 경우에도 중복 미러 로그를 만들 수 있습니다.

미러가 생성되면 미러 지역이 동기화됩니다. 대규모 미러 구성 요소의 경우 동기화 프로세스에 시간이 오래 걸릴 수 있습니다. 다시 시작할 필요가 없는 새 미러를 만드는 경우

--nosync 인수를 지정하여 첫 번째 장치의 초기 동기화가 필요하지 않음을 나타낼 수 있습니다.