3.10. Ceph 스토리지 용량

Red Hat Ceph Storage 클러스터가 최대 용량에 근접하게 되면( mon_osd_full_ratio 매개 변수로 지정됨) Ceph는 데이터 손실을 방지하기 위해 Ceph OSD를 참조하거나 읽을 수 없습니다. 따라서 Red Hat Ceph Storage 클러스터가 전체 비율을 달성할 수 있도록 하는 것은 고가용성을 희생하기 때문에 좋은 방법이 아닙니다. 기본 전체 비율은 .95 또는 95% 용량입니다. 이 설정은 OSD 수가 적은 테스트 클러스터에 매우 공격적인 설정입니다.

클러스터를 모니터링할 때 거의 전체 비율과 관련된 경고에 경고해야 합니다. 즉, 하나 이상의 OSD가 실패하면 일부 OSD가 실패하면 서비스가 일시 중단될 수 있습니다. 스토리지 용량을 늘리려면 OSD를 추가하는 것이 좋습니다.

테스트 클러스터의 일반적인 시나리오에는 시스템 관리자가 Red Hat Ceph Storage 클러스터에서 Ceph OSD를 제거하여 클러스터 재조정을 감시하는 작업이 포함됩니다. 그런 다음 Red Hat Ceph Storage 클러스터가 전체 비율 및 잠금에 도달할 때까지 다른 Ceph OSD를 제거합니다.

Red Hat은 테스트 클러스터에서도 약간의 용량 계획을 권장합니다. 계획을 사용하면 고가용성을 유지하기 위해 필요한 예비 용량을 측정할 수 있습니다.

클러스터가 Ceph OSD를 즉시 교체하지 않고 활성 + 정리 상태로 복구할 수 있는 일련의 Ceph OSD 실패를 계획하는 것이 좋습니다. 활성 + 성능이 저하된 상태에서 클러스터를 실행할 수 있지만 일반적인 운영 조건에는 이상적이지 않습니다.

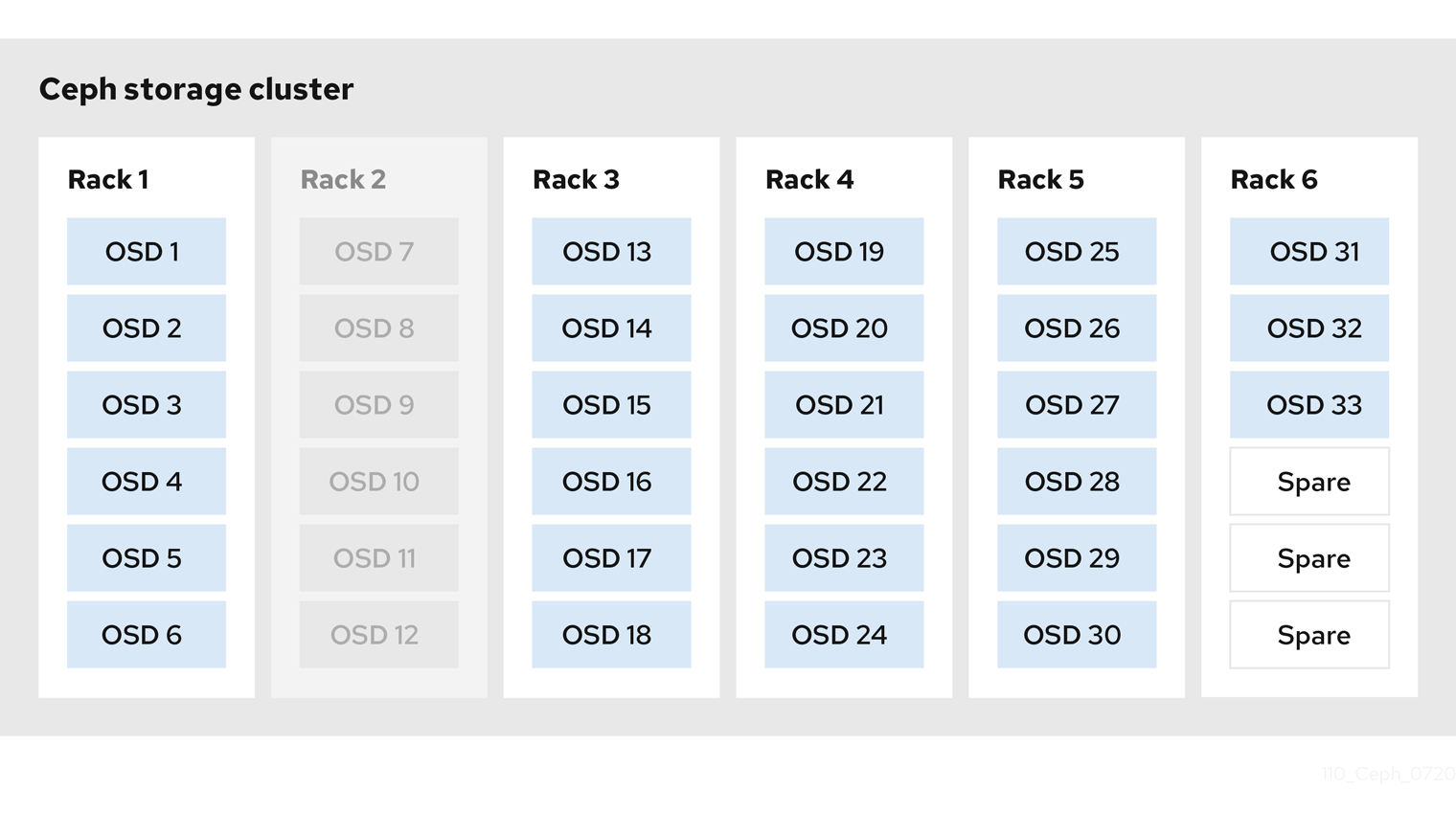

다음 다이어그램에서는 호스트당 하나의 Ceph OSD가 있는 33개의 Ceph 노드가 포함되어 있으며 각 Ceph OSD 데몬이 3TB 드라이브에서 읽고 쓰는 각 Ceph OSD 데몬이 포함된 간단한 Red Hat Ceph Storage 클러스터를 보여줍니다. 따라서 이 예제의 Red Hat Ceph Storage 클러스터는 최대 99TB의 실제 용량을 갖습니다. mond 의 전체 비율이 4.85인 경우 Red Hat Ceph Storage 클러스터가 5TB의 나머지 용량으로 떨어지면 클러스터에서 Ceph 클라이언트가 데이터를 읽고 쓸 수 없습니다. 따라서 Red Hat Ceph Storage 클러스터의 운영 용량은 99TB가 아닌 95TB입니다.

이러한 클러스터의 경우 하나 또는 두 개의 OSD가 실패하는 것이 일반적입니다. 덜 빈번하지만 합리적인 시나리오에서는 랙의 라우터 또는 전원 공급이 실패하여 여러 OSD(예: OSD 7-12)가 동시에 중단됩니다. 이러한 시나리오에서는 작동 상태를 유지하고 활성 + 클린 상태가 될 수 있는 클러스터를 위해 계속 노력해야 합니다. 즉, 추가 OSD가 있는 몇 개의 호스트를 짧은 순서로 추가하는 경우에도 마찬가지입니다. 용량 사용률이 너무 높으면 데이터가 손실되지 않을 수 있지만 클러스터의 용량 사용률이 전체 비율을 초과하면 장애 도메인 내에서 중단을 해결하는 동안 데이터 가용성을 희생할 수 있습니다. 이러한 이유로 최소한 대략적인 용량 계획을 수립하는 것이 좋습니다.

클러스터의 두 숫자를 확인합니다.

- OSD 수

- 클러스터의 총 용량

클러스터 내에서 OSD의 평균 용량을 결정하려면 클러스터의 총 용량을 클러스터의 OSD 수로 나눕니다. 일반 작업(이 비교적 적은 수) 동안 동시에 실패할 것으로 예상되는 OSD 수를 곱하는 것이 좋습니다. 마지막으로 최대 운영 용량에 도달하기 위해 클러스터 용량에 전체 비율을 곱합니다. 그런 다음 적절한 전체 비율에 도달하지 못하는 OSD에서 데이터 양을 뺀다. OSD 실패 수가 많은 수(예: OSD 랙)를 통해 포지셔닝 프로세스를 반복하여 거의 전체 비율을 위해 적절한 개수로 도착합니다.