오브젝트 게이트웨이 구성 및 관리 가이드

Ceph Storage 오브젝트 게이트웨이 구성 및 관리

초록

1장. 개요

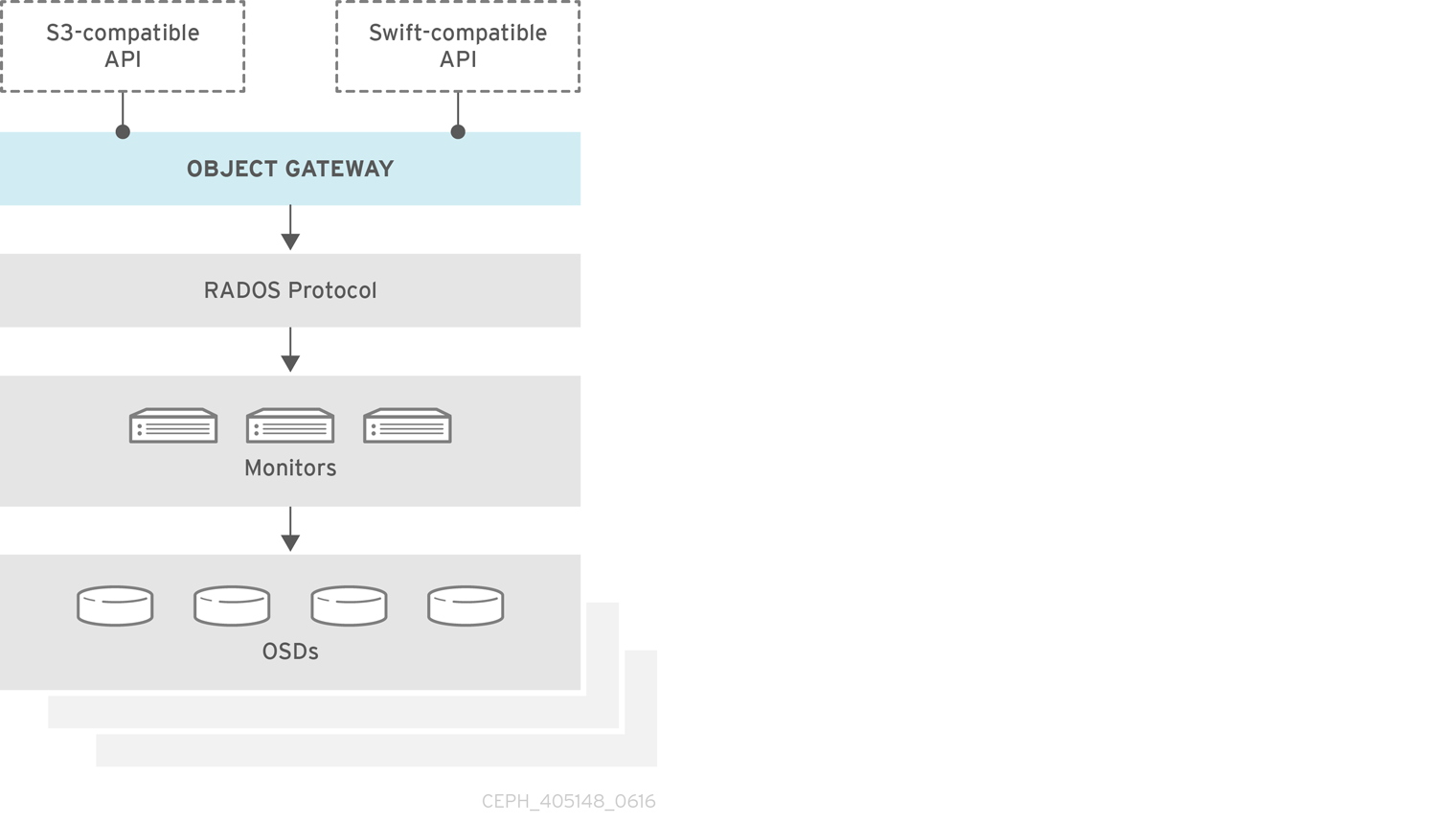

Ceph 개체 게이트웨이(RGW(RADOS Gateway)라고도 함)는 Ceph 스토리지 클러스터에 대한 RESTful 게이트웨이를 애플리케이션에 제공하기 위해 librados 상단에 빌드된 오브젝트 스토리지 인터페이스입니다. Ceph 개체 게이트웨이는 다음 두 개의 인터페이스를 지원합니다.

- S3 호환 : Amazon S3 RESTful API의 큰 하위 집합과 호환되는 인터페이스가 포함된 오브젝트 스토리지 기능을 제공합니다.

- Swift 호환: OpenStack Swift API의 대규모 하위 집합과 호환되는 인터페이스가 포함된 오브젝트 스토리지 기능을 제공합니다.

Ceph 개체 게이트웨이는 Ceph 스토리지 클러스터와 상호 작용하는 서버입니다. OpenStack Swift 및 Amazon S3와 호환되는 인터페이스를 제공하므로 Ceph 개체 게이트웨이에 고유한 사용자 관리가 있습니다. Ceph 개체 게이트웨이는 Ceph 블록 장치 클라이언트의 데이터를 저장하는 데 사용되는 동일한 Ceph 스토리지 클러스터에 데이터를 저장할 수 있지만 별도의 풀과 다른 CRUSH 계층 구조가 필요합니다. S3 및 Swift API는 공통 네임스페이스를 공유하므로 하나의 API로 데이터를 작성하고 다른 API와 검색할 수 있습니다.

RGW에서 사용하는 풀에서 RADOS 스냅샷을 사용하지 마십시오. 이렇게 하면 바람직하지 않은 데이터 불일치가 발생할 수 있습니다.

2장. 설정

2.1. Beast 및 CivetWeb 프런트 엔드 웹 서버

Ceph 개체 게이트웨이는 Beast 및 CivetWeb을 프런트 엔드로 제공하며 둘 다 C/C++ 임베디드 웹 서버입니다.

Beast

Red Hat Ceph Storage 4부터 Beast는 기본 프런트 엔드 웹 서버입니다. Red Hat Ceph Storage 3에서 업그레이드할 때 rgw_frontends 매개변수는 자동으로 Beast로 변경됩니다. beast는 Boost.Beast C++ 라이브러리를 사용하여 HTTP를 구문 분석하고 Boost.Asio 는 비동기 네트워크 I/O를 수행합니다.

CivetWeb

Red Hat Ceph Storage 3에서 CivetWeb은 기본 프런트엔드이지만, Beast는 rgw_frontends 옵션을 적절하게 설정하여 사용할 수도 있습니다. CivetWeb은 Mongoose 프로젝트의 포크인 HTTP 라이브러리입니다.

추가 리소스

2.2. Beast 프론트 엔드 사용

Ceph 개체 게이트웨이는 CivetWeb 및 Beast 포함된 HTTP 서버를 프런트 엔드로 제공합니다. Beast 프론트엔드는 HTTP 구문 분석에 Boost.Beast 라이브러리를 사용하고 비동기 네트워크 I/O에 Boost.Asio 라이브러리를 사용합니다. Red Hat Ceph Storage 버전 3.x에서 CivetWeb은 기본 프런트엔드였습니다. Beast 프론트엔드를 Red Hat Ceph Storage 구성 파일의 rgw_frontends 로 지정해야 했습니다. Red Hat Ceph Storage 버전 4.0에서 Beast 프런트 엔드는 기본이며 Red Hat Ceph Storage 3.x에서 업그레이드하면 rgw_frontends 매개변수가 Beast로 자동으로 변경됩니다.

추가 리소스

2.3. Beast 구성 옵션

다음 Beast 구성 옵션은 RADOS 게이트웨이의 Ceph 구성 파일의 포함된 웹 서버에 전달할 수 있습니다. 각 옵션에는 기본값이 있습니다. 값을 지정하지 않으면 기본값이 비어 있습니다.

| 옵션 | 설명 | Default |

|---|---|---|

|

|

주소가 점으로 지정된 10진수 형식의 IPv4 주소 문자열인 | 비어있습니다 |

|

| SSL 지원 엔드포인트에 사용되는 SSL 인증서 파일의 경로입니다. 파일이 두 개 이상의 항목이 포함된 PEM 파일인 경우 순서가 중요합니다. 파일은 RGW 서버 키, 그 다음에는 중간 인증서, 마지막으로 CA 인증서로 시작해야 합니다. | 비어있습니다 |

|

|

SSL 지원 엔드포인트에 사용되는 개인 키 파일의 선택적 경로입니다. | 비어있습니다 |

|

| 일부 환경에서 성능 최적화. | 비어있습니다 |

|

| Beast 프런트 엔드에 대한 명시적 요청 타임아웃을 설정합니다. 더 큰 요청 시간 제한을 설정하면 게이트웨이가 느린 클라이언트(예: 대기 시간이 긴 네트워크를 통해 연결된 클라이언트)를 더 엄격하게 수행할 수 있습니다. | 65 |

SSL을 사용하여 Beast 옵션이 있는 /etc/ceph/ceph.conf 파일의 예:

... [client.rgw.node1] rgw frontends = beast ssl_endpoint=192.168.0.100:443 ssl_certificate=<path to SSL certificate>

기본적으로 Beast 프론트엔드는 서버가 처리하는 모든 요청을 RADOS 게이트웨이 로그 파일에 기록하는 액세스 로그 행을 작성합니다.

추가 리소스

- 자세한 내용은 Beast 프론트엔드 사용을 참조하십시오.

2.4. CivetWeb 포트 변경

Ansible을 사용하여 Ceph Object Gateway를 설치하는 경우 포트 8080 에서 실행되도록 CivetWeb을 구성합니다. Ansible은 Ceph 구성 파일에서 다음과 유사한 행을 추가하여 이 작업을 수행합니다.

rgw frontends = civetweb port=192.168.122.199:8080 num_threads=100

Ceph 구성 파일에 rgw frontends = civetweb 행이 포함되지 않은 경우 Ceph Object Gateway는 포트 7480 에서 수신 대기합니다. rgw_frontends = civetweb 행이 포함되지만 포트가 지정되지 않은 경우 Ceph Object Gateway는 포트 80 에서 수신 대기합니다.

Ansible은 포트 8080 에서 수신 대기하도록 Ceph Object Gateway를 구성하고 Red Hat Ceph Storage 4를 설치하는 지원되는 방법은 ceph-ansible 을 사용하므로 포트 8080 은 Red Hat Ceph Storage 4 설명서의 기본 포트로 간주됩니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 4.1 클러스터.

- Ceph Object Gateway 노드.

절차

-

게이트웨이 노드에서

/etc/ceph/디렉터리에서 Ceph 구성 파일을 엽니다. 예제와 유사한 Ceph 개체 게이트웨이(RGW) 클라이언트 섹션을 찾습니다.

[client.rgw.gateway-node1] host = gateway-node1 keyring = /var/lib/ceph/radosgw/ceph-rgw.gateway-node1/keyring log file = /var/log/ceph/ceph-rgw-gateway-node1.log rgw frontends = civetweb port=192.168.122.199:8080 num_threads=100

[client.rgw.gateway-node1]제목은 Ceph 구성 파일의 이 부분을 클라이언트 유형이rgw로 식별된 Ceph Object Gateway인 Ceph Storage Cluster 클라이언트를 구성하고, 노드 이름은gateway-node1입니다.Ansible 구성 포트

8080을80으로 변경하려면rgw frontends 행을편집합니다.rgw frontends = civetweb port=192.168.122.199:80 num_threads=100

rgw_frontends키/값 쌍에port= port-number사이에 공백이 없는지 확인합니다.포트를 변경할 다른 게이트웨이 노드에서 이 단계를 반복합니다.

각 게이트웨이 노드에서 Ceph Object Gateway 서비스를 다시 시작하여 새 포트 설정이 적용되도록 합니다.

# systemctl restart ceph-radosgw.target

각 게이트웨이 노드의 방화벽에서 구성된 포트가 열려 있는지 확인합니다.

# firewall-cmd --list-all

포트가 열리지 않으면 포트를 추가하고 방화벽 구성을 다시 로드합니다.

# firewall-cmd --zone=public --add-port 80/tcp --permanent # firewall-cmd --reload

추가 리소스

2.5. Civetweb에서 SSL 사용

Red Hat Ceph Storage 1에서 Ceph Object Gateway에 대한 Civetweb SSL은 HAProxy 및 keepalived에 의존합니다. Red Hat Ceph Storage 2 이상 릴리스에서는 Civetweb에서 OpenSSL 라이브러리를 사용하여 TLS(Transport Layer Security)를 제공할 수 있습니다.

프로덕션 배포에서는 HAProxy 를 사용하고 keepalived를 사용하여 HAProxy에서 SSL 연결을 종료해야 합니다. 소규모 규모의 테스트 및 사전 프로덕션 배포에서는 Civetweb과 SSL을 사용하는 것이 좋습니다.

Civetweb에서 SSL을 사용하려면 게이트웨이 노드의 호스트 이름과 일치하는 CA(인증 기관)에서 인증서를 가져옵니다. Red Hat은 S3 스타일 하위 도메인에 사용할 대상 대체 이름 필드와 와일드카드가 있는 CA에서 인증서를 가져오는 것이 좋습니다.

Civetweb에는 하나의. pem 파일에 키, 서버 인증서 및 기타 인증 기관 또는 중간 인증서가 필요합니다.

.pem 파일에는 비밀 키가 포함되어 있습니다. .pem 파일을 무단 액세스로부터 보호합니다.

SSL의 포트를 구성하려면 포트 번호를 rgw_frontends 에 추가하고 s 를 포트 번호에 추가하여 보안 포트임을 나타냅니다. 또한. pem 파일의 경로와 함께 ssl_certificate 를 추가합니다. 예를 들면 다음과 같습니다.

[client.rgw.{hostname}]

rgw_frontends = "civetweb port=443s ssl_certificate=/etc/ceph/private/server.pem"2.6. Civetweb 구성 옵션

다음 Civetweb 구성 옵션은 RADOS 게이트웨이의 Ceph 구성 파일에 있는 포함된 웹 서버에 전달할 수 있습니다. 각 옵션에 기본값이 있으며 값이 지정되지 않은 경우 기본값은 비어 있습니다.

| 옵션 | 설명 | Default |

|---|---|---|

|

| 액세스 로그 파일의 경로입니다. 전체 경로 또는 현재 작업 디렉터리를 기준으로 합니다. absent(기본값)가 없으면 액세스가 기록되지 않습니다. | 비어있습니다 |

|

| 오류 로그 파일의 경로입니다. 전체 경로 또는 현재 작업 디렉터리를 기준으로 합니다. 값이 없으면(기본값) 오류가 기록되지 않습니다. | 비어있습니다 |

|

| 작업자 스레드 수입니다. Civetweb은 들어오는 각 연결을 별도의 스레드에서 처리합니다. 따라서 이 옵션의 값은 Civetweb에서 처리할 수 있는 동시 HTTP 연결 수입니다. | 50 |

|

| 네트워크 읽기 및 네트워크 쓰기 작업에 대한 시간 초과(밀리초). 클라이언트가 장기 실행 연결을 유지하려는 경우 이 값을 늘리거나 (더 나은) keep-alive 메시지를 사용합니다. | 30000 |

다음은 이러한 옵션이 설정된 /etc/ceph/ceph.conf 파일의 예입니다.

... [client.rgw.node1] rgw frontends = civetweb request_timeout_ms=30000 error_log_file=/var/log/radosgw/civetweb.error.log access_log_file=/var/log/radosgw/civetweb.access.log

CivetWeb 및 Beast 프론트엔드 모두 서버가 처리하는 모든 요청에 대한 액세스 로그 라인 기록을 RADOS 게이트웨이 로그 파일에 기록합니다.

2.7. DNS에 와일드카드 추가

S3 스타일 하위 도메인과 함께 Ceph를 사용하려면(예: bucket-name.domain-name.com ) 데몬 에서 도메인 이름을 확인하는 데 사용하는 DNS 서버의 DNS 레코드에 와일드카드를 추가합니다.

dnsmasq 의 경우 호스트 이름에 앞에 점(.)을 사용하여 다음 주소 설정을 추가합니다.

address=/.{hostname-or-fqdn}/{host-ip-address}예를 들면 다음과 같습니다.

address=/.gateway-node1/192.168.122.75

바인드 하려면 DNS 레코드에 와일드카드를 추가합니다. 예를 들면 다음과 같습니다.

$TTL 604800

@ IN SOA gateway-node1. root.gateway-node1. (

2 ; Serial

604800 ; Refresh

86400 ; Retry

2419200 ; Expire

604800 ) ; Negative Cache TTL

;

@ IN NS gateway-node1.

@ IN A 192.168.122.113

* IN CNAME @

DNS 서버를 다시 시작하고 하위 도메인으로 서버를 ping하여 ceph-radosgw 데몬이 하위 도메인 요청을 처리할 수 있는지 확인합니다.

ping mybucket.{hostname}예를 들면 다음과 같습니다.

ping mybucket.gateway-node1

DNS 서버가 로컬 시스템에 있는 경우 로컬 시스템의 nameserver 항목을 추가하여 /etc/resolv.conf 를 수정해야 할 수도 있습니다.

마지막으로 rgw_dns_name = {hostname} 설정을 사용하여 Ceph 구성 파일의 적절한 섹션에서 DNS 서버의 호스트 이름 또는 주소를 지정합니다. 예를 들면 다음과 같습니다.

[client.rgw.{instance}]

[client.rgw.rgw1.rgw0]

...

rgw_dns_name = {hostname}

모범 사례로 관리 노드 또는 ceph-anible 과 같은 중앙 집중식 위치에서 Ceph 구성 파일을 변경하고 필요에 따라 구성 파일을 재배포하여 클러스터 전체의 일관성을 보장합니다.

마지막으로 DNS 설정이 적용되도록 Ceph 개체 게이트웨이를 다시 시작합니다.

2.8. 로깅 및 디버깅 출력 조정

설정 절차를 완료한 후 로깅 출력을 확인하여 요구 사항을 충족하는지 확인합니다. 구성에 문제가 발생하면 Ceph 구성 파일의 [global] 섹션에서 로깅 및 디버깅 메시지를 늘리고 게이트웨이를 다시 시작하여 구성 문제를 해결할 수 있습니다. 예를 들면 다음과 같습니다.

[global] #append the following in the global section. debug ms = 1 debug civetweb = 20

RGW 디버그 로그의 경우 Ceph 구성 파일의 [client.rgw.{instance}] 섹션에 다음 매개변수를 추가합니다.

[client.rgw.rgw1.rgw0] ... debug rgw = 20

이러한 설정을 런타임에 수정할 수도 있습니다. 예를 들면 다음과 같습니다.

# ceph tell osd.0 injectargs --debug_civetweb 10/20

Ceph 로그 파일은 기본적으로 /var/log/ceph 에 있습니다.

로깅 및 디버깅에 대한 일반적인 내용은 Red Hat Ceph Storage 구성 가이드의 Ceph 디버깅 및 로깅 구성 섹션을 참조하십시오.

2.9. S3 서버 측 암호화

Ceph Object Gateway는 S3 API(애플리케이션 프로그래밍 인터페이스)에 대해 업로드된 오브젝트의 서버 측 암호화를 지원합니다. 서버 측 암호화는 S3 클라이언트가 HTTP를 통해 암호화되지 않은 형태로 데이터를 보내고 Ceph Object Gateway는 해당 데이터를 Red Hat Ceph Storage 클러스터에 암호화된 형식으로 저장함을 의미합니다.

Red Hat은 SLO(Static Large Object) 또는 DLO(Dynamic Large Object)의 S3 객체 암호화를 지원하지 않습니다.

암호화를 사용하려면 클라이언트 요청에서 SSL 연결을 통해 요청을 보내야 합니다. Red Hat은 Ceph Object Gateway에서 SSL을 사용하지 않는 한 클라이언트에서 S3 암호화를 지원하지 않습니다. 그러나 테스트 목적으로 관리자는 런타임 시 rgw_crypt_require_ssl 구성 설정을 false로 설정하고, Ceph 구성 파일에서 false 로 설정하고 게이트웨이 인스턴스를 다시 시작하거나, Ansible 구성 파일에서 false로 설정하여 Ceph Object Gateway에 대한 Ansible 플레이북을 재생하여 테스트 중에 SSL을 비활성화할 수 있습니다.

프로덕션 환경에서는 암호화된 요청을 SSL을 통해 보낼 수 없습니다. 이러한 경우 HTTP를 서버 측 암호화와 함께 사용하여 요청을 보냅니다.

서버 측 암호화를 사용하여 HTTP를 구성하는 방법에 대한 자세한 내용은 아래 추가 리소스 섹션을 참조하십시오.

암호화 키 관리에 대한 두 가지 옵션이 있습니다.

고객 제공 키

고객 제공 키를 사용하는 경우 S3 클라이언트는 암호화된 데이터를 읽거나 쓰기 위한 각 요청과 함께 암호화 키를 전달합니다. 이러한 키를 관리하는 것은 고객의 책임입니다. 고객은 각 오브젝트를 암호화하는 데 사용되는 Ceph 개체 게이트웨이를 기억해야 합니다.

Ceph Object Gateway는 Amazon SSE-C 사양에 따라 S3 API에서 고객 제공 키 동작을 구현합니다.

고객이 키 관리를 처리하고 S3 클라이언트는 Ceph Object Gateway에 키를 전달하므로 Ceph Object Gateway에는 이 암호화 모드를 지원하는 특별한 구성이 필요하지 않습니다.

키 관리 서비스

키 관리 서비스를 사용하는 경우 보안 키 관리 서비스는 키를 저장하고 Ceph Object Gateway는 필요에 따라 데이터를 암호화하거나 암호 해독하기 위한 요청을 제공합니다.

Ceph Object Gateway는 Amazon SSE-KMS 사양에 따라 S3 API에서 키 관리 서비스 동작을 구현합니다.

현재 테스트된 유일한 키 관리 구현은 H¢Corp Vault와 OpenStack Barbican입니다. 그러나 OpenStack Barbican은 기술 프리뷰이며 프로덕션 시스템에서 사용할 수 없습니다.

2.10. 서버 측 암호화 요청

프로덕션 환경에서 클라이언트는 프록시를 통해 Ceph 개체 게이트웨이에 연결하는 경우가 많습니다. 이 프록시는 여러 Ceph Object Gateway에 연결되므로 로드 밸런서라고 합니다. 클라이언트가 Ceph Object Gateway에 요청을 보내면 로드 밸런서에서 이러한 요청을 여러 Ceph Object Gateway에 라우팅하여 워크로드를 배포합니다.

이 유형의 구성에서는 로드 밸런서 및 여러 Ceph 개체 게이트웨이 간에 SSL 종료가 발생할 수 있습니다. HTTP만 사용하는 통신이 발생합니다. 서버 측 암호화 요청을 수락하도록 Ceph Object Gateways를 설정하려면 서버 측 암호화 구성을 참조하십시오.

2.11. 서버 측 암호화 구성

스토리지 관리자는 HTTP를 사용하여 암호화된 요청을 SSL을 통해 보낼 수 없는 경우 HTTP를 사용하여 Ceph Object Gateway에 요청을 보내도록 서버 측 암호화를 설정할 수 있습니다.

이 절차에서는 HAProxy를 프록시 및 로드 밸런서로 사용합니다.

사전 요구 사항

- 스토리지 클러스터의 모든 노드에 대한 루트 수준 액세스.

- 실행 중인 Red Hat Ceph Storage 클러스터.

- Ceph Object Gateway가 설치되어 있습니다.

- HAProxy가 설치되어 있어야 합니다.

절차

haproxy.cfg파일을 편집합니다.예제

frontend http_web bind *:80 mode http default_backend rgw frontend rgw-https bind *:443 ssl crt /etc/ssl/private/example.com.pem default_backend rgw backend rgw balance roundrobin mode http server rgw1 10.0.0.71:8080 check server rgw2 10.0.0.80:8080 checkhttp프런트엔드에 대한 액세스를 허용하는 행을 주석 처리하고 대신https프런트엔드를 사용하도록 HAProxy에 지시하는 지침을 추가합니다.예제

# frontend http_web # bind *:80 # mode http # default_backend rgw frontend rgw-https bind *:443 ssl crt /etc/ssl/private/example.com.pem http-request set-header X-Forwarded-Proto https if { ssl_fc } http-request set-header X-Forwarded-Proto https # here we set the incoming HTTPS port on the load balancer (eg : 443) http-request set-header X-Forwarded-Port 443 default_backend rgw backend rgw balance roundrobin mode http server rgw1 10.0.0.71:8080 check server rgw2 10.0.0.80:8080 check클러스터의 모든 노드에서 다음 매개변수를 Ceph 구성 파일의

[global]섹션에 추가합니다.rgw_trust_forwarded_https=true

HAProxy를 활성화하고 시작합니다.

[root@haproxy]# systemctl enable haproxy [root@haproxy]# systemctl start haproxy

Ansible이 실행될 때

rgw_trust_forwarded_https=true가 Ceph 구성 파일에서 제거되지 않도록 ceph-ansibleall.yml파일을 편집하고ceph_conf를_overrides / global 섹션의 rgw_trust_forwarded_httpstrue로 설정합니다.ceph_conf_overrides: global: rgw_trust_forwarded_https: true- 변경이 완료되면 ceph-ansible 플레이북을 실행하여 모든 Ceph 노드에서 구성을 업데이트합니다.

2.12. H¢Corp Vault

스토리지 관리자는 Ceph Object Gateway와 함께 사용할 수 있도록 키, 암호 및 인증서를 HseaCorp Vault에 안전하게 저장할 수 있습니다. H¢Corp Vault는 Ceph 개체 게이트웨이에서 사용하는 서버 측 암호화에 대해 안전한 키 관리 서비스를 제공합니다.

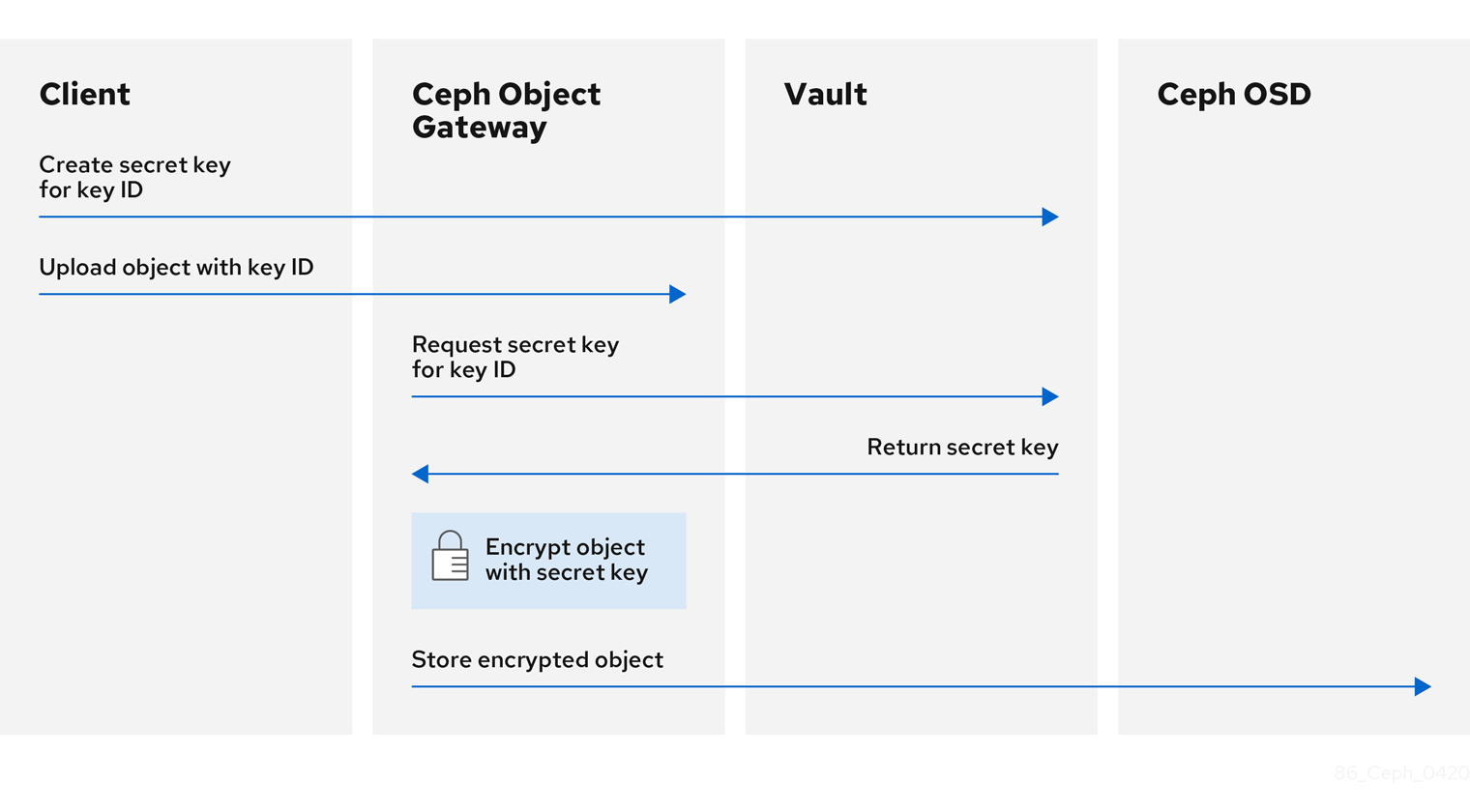

기본 워크플로우:

- 클라이언트는 오브젝트의 키 ID를 기반으로 Vault에서 비밀 키 생성을 요청합니다.

- 클라이언트는 오브젝트의 키 ID가 있는 오브젝트를 Ceph Object Gateway에 업로드합니다.

- 그러면 Ceph Object Gateway에서 Vault에서 새로 생성된 비밀 키를 요청합니다.

- Vault는 비밀 키를 Ceph 개체 게이트웨이에 반환하여 요청에 응답합니다.

- 이제 Ceph Object Gateway에서 새 비밀 키를 사용하여 오브젝트를 암호화할 수 있습니다.

- 암호화가 완료되면 오브젝트가 Ceph OSD에 저장됩니다.

Red Hat은 기술 파트너와 협력하여 이 문서를 고객에게 서비스로 제공하고 있습니다. 그러나 Red Hat은 이 제품에 대한 지원을 제공하지 않습니다. 이 제품에 대한 기술 지원이 필요한 경우 H¢corp에 문의하십시오.

2.12.1. 사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- Ceph Object Gateway 소프트웨어 설치.

- HCorp Vault 소프트웨어 설치.

2.12.2. Vault 용 비밀 엔진

HseaCorp Vault는 데이터를 생성, 저장 또는 암호화할 수 있는 여러 가지 비밀 엔진을 제공합니다. API(애플리케이션 프로그래밍 인터페이스)는 해당 데이터에 대한 작업을 요청하는 시크릿 엔진에 데이터 호출을 전송하고 시크릿 엔진은 해당 작업 요청의 결과를 반환합니다.

Ceph Object Gateway는 H¢Corp Vault 비밀 엔진을 2개 지원합니다.

- 키/값 버전 2

- 전환

키/값 버전 2

키/값 시크릿 엔진은 Vault 내에 디스크의 임의 시크릿을 저장합니다. kv 엔진 버전 2를 사용하면 키에 구성 가능한 개수의 버전이 있을 수 있습니다. 기본 버전 수는 10입니다. 버전을 삭제하면 기본 데이터가 삭제되지 않지만 데이터가 삭제된 것으로 표시되므로 삭제된 버전을 삭제하지 않을 수 있습니다. 키 이름은 문자열이어야 하며, 명령줄 인터페이스를 사용할 때 엔진은 문자열이 아닌 값을 문자열로 변환합니다. 문자열이 아닌 값을 보존하려면 JSON 파일을 제공하거나 HTTP API(애플리케이션 프로그래밍 인터페이스)를 사용합니다.

ACL(액세스 제어 목록) 정책의 경우 Key/Value secret 엔진은 생성과 업데이트 기능 간의 차이점을 인식합니다.

전환

Transit 비밀 엔진은 전송 중인 데이터에서 암호화 기능을 수행합니다. Transit 비밀 엔진은 해시를 생성할 수 있으며 임의 바이트의 소스일 수 있으며 데이터를 서명하고 확인할 수도 있습니다. Vault는 Transit 비밀 엔진을 사용할 때 데이터를 저장하지 않습니다. Transit 비밀 엔진은 동일한 키를 여러 용도로 사용할 수 있도록 함으로써 키 파생을 지원합니다. 또한 전송 비밀 엔진은 키 버전 지정을 지원합니다. Transit 비밀 엔진은 다음과 같은 주요 유형을 지원합니다.

aes128-gcm96- 128비트 AES 키와 96비트 nonce를 사용하는 AES-GCM; 암호화, 암호 해독, 키 파생 및 통합 암호화 지원

aes256-gcm96- 256비트 AES 키와 96비트 nonce를 사용하는 AES-GCM; 암호화, 암호 해독, 키 파생 및 통합 암호화(기본값) 지원

chacha20-poly1305- 256비트 키가 있는 ChaCha20-Poly1305, 암호화, 암호 해독, 키 파생 및 통합된 암호화 지원

ed25519- Ed25519; 서명, 서명 확인 및 키 파생 지원

ecdsa-p256- 곡선 P-256을 사용하는 ECDSA; 서명 및 서명 확인 지원

ecdsa-p384- 곡선 P-384를 사용하는 ECDSA; 서명 및 서명 확인 지원

ecdsa-p521- 곡선 P-521을 사용하는 ECDSA, 서명 및 서명 확인 지원

rsa-2048- 2048비트 RSA 키. 암호화, 암호 해독, 서명 및 서명 확인 지원

rsa-3072- 3072비트 RSA 키; 암호화, 암호 해독, 서명 및 서명 확인 지원

rsa-4096- 4096비트 RSA 키; 암호화, 암호 해독, 서명 및 서명 확인 지원

추가 리소스

- 자세한 내용은 Vault의 프로젝트 사이트에 대한 KV Secrets Engine 설명서를 참조하십시오.

- 자세한 내용은 Vault의 프로젝트 사이트에 대한 Transit Secrets Engine 설명서를 참조하십시오.

2.12.3. Vault를 위한 인증

H¢Corp Vault는 여러 유형의 인증 메커니즘을 지원합니다. Ceph Object Gateway는 현재 Vault 에이전트 및 토큰 인증 방법을 지원합니다. Ceph Object Gateway는 rgw_crypt_vault_auth 및 rgw_crypt_vault_addr 옵션을 사용하여 H¢Corp Vault 사용을 구성합니다.

토큰

토큰 인증 방법을 사용하면 사용자가 토큰을 사용하여 인증할 수 있습니다. 새 토큰을 생성하고, 토큰으로 시크릿을 취소하고, 다른 많은 토큰 작업을 수행할 수 있습니다. 토큰 저장소를 사용하여 다른 인증 방법을 바이패스할 수 있습니다. 토큰 인증 방법을 사용하는 경우 rgw_crypt_vault_token_file 옵션도 사용해야 합니다. 토큰 파일은 Ceph Object Gateway에서만 읽을 수 있습니다. 또한 특정 경로에서 인증 키를 가져올 수 있는 제한된 정책이 있는 Vault 토큰을 사용해야 합니다.

프로덕션 환경에서는 토큰 인증을 사용하지 않는 것이 좋습니다.

Vault 에이전트

Vault 에이전트는 클라이언트 노드에서 실행되고 토큰 갱신과 함께 클라이언트 측 캐싱을 제공하는 데몬입니다. Vault 에이전트는 일반적으로 Ceph Object Gateway 노드에서 실행됩니다.

추가 리소스

- 자세한 내용은 Vault의 프로젝트 사이트에 대한 토큰 인증 방법 설명서를 참조하십시오.

- 자세한 내용은 Vault의 프로젝트 사이트에 대한 Vault Agent 문서를 참조하십시오.

2.12.4. Vault용 네임 스페이스

H¢Corp Vault를 엔터프라이즈 서비스로 사용하면 조직 내에서 팀에서 사용할 수 있는 격리된 네임스페이스에 대한 중앙 집중식 관리가 제공됩니다. 이러한 분리된 네임스페이스 환경을 테넌트 라고 하며, 조직 내 팀은 이러한 테넌트 를 활용하여 정책, 비밀 및 ID를 다른 팀으로부터 격리할 수 있습니다. Vault의 네임스페이스 기능은 단일 인프라 내에서 보안 멀티 테넌시를 지원하는 데 도움이 됩니다.

추가 리소스

- 자세한 내용은 Vault의 프로젝트 사이트에 대한 Vault Enterprise 네임스페이스 설명서를 참조하십시오.

2.12.5. Vault를 사용하도록 Ceph Object Gateway 구성

H¢Corp Vault를 사용하도록 Ceph Object Gateway를 구성하려면 암호화 키 저장소로 설정해야 합니다. 현재 Ceph Object Gateway는 두 가지 비밀 엔진과 두 가지 다른 인증 방법을 지원합니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- Ceph Object Gateway 소프트웨어 설치.

- Ceph Object Gateway 노드에 대한 루트 수준 액세스.

절차

Ceph 구성 파일을 편집하기 위해 기본적으로

/etc/ceph/ceph.conf를 열고 암호화 키 저장소로 Vault를 활성화합니다.rgw_crypt_s3_kms_backend = vault

[client.radosgw.INSTANCE_NAME]섹션에서 Vault 인증 방법인 Token 또는 Vault 에이전트를 선택합니다.Token 을 사용하는 경우 다음 행을 추가합니다.

rgw_crypt_vault_auth = token rgw_crypt_vault_token_file = /etc/ceph/vault.token rgw_crypt_vault_addr = http://VAULT_SERVER:8200Vault 에이전트를 사용하는 경우 다음 행을 추가합니다.

rgw_crypt_vault_auth = agent rgw_crypt_vault_addr = http://VAULT_SERVER:8100

[client.radosgw.INSTANCE_NAME]섹션에서 Vault 시크릿 엔진(키/값 또는 전송)을 선택합니다.Key/Value 를 사용하는 경우 다음 행을 추가합니다.

rgw_crypt_vault_secret_engine = kv

Transit 을 사용하는 경우 다음 행을 추가합니다.

rgw_crypt_vault_secret_engine = transit

선택적으로

[client.radosgw.INSTANCE_NAME]섹션에서 암호화 키를 검색할 Vault 네임스페이스를 설정할 수 있습니다.rgw_crypt_vault_namespace = NAME_OF_THE_NAMESPACE경로 접두사를 설정하여 Ceph Object Gateway에서 Vault에서 암호화 키를 검색하는 위치를 제한합니다.

예제

rgw_crypt_vault_prefix = /v1/secret/data

내보낼 수 있는 전송 키의 경우 다음과 같이 접두사 경로를 설정합니다.

rgw_crypt_vault_prefix = /v1/transit/export/encryption-key

Vault 서버의 도메인 이름이

vault-server라고 가정하면 Ceph Object Gateway는 다음 URL에서 암호화된 전송 키를 가져옵니다.예제

http://vault-server:8200/v1/transit/export/encryption-key

- Ceph 구성 파일에 변경 사항을 저장합니다.

추가 리소스

- 자세한 내용은 Red Hat Ceph Storage Object Gateway Configuration and Administration Guide 의 Vault용 Secret Engine 섹션을 참조하십시오.

- 자세한 내용은 Red Hat Ceph Storage Object Gateway Configuration and Administration Guide 의 Vault에 대한 인증 섹션을 참조하십시오.

2.12.6. kv 엔진을 사용하여 키 생성

Ceph Object Gateway에서 사용할 키를 만들 수 있도록 HCorp Vault Key/Value Secret Engine(kv)을 구성합니다. 시크릿은 kv 시크릿 엔진에 키-값 쌍으로 저장됩니다.

서버 측 암호화 키는 256비트이고 base64 를 사용하여 인코딩되어야 합니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- HCorp Vault 소프트웨어 설치.

- HseaCorp Vault 노드에 대한 루트 수준 액세스.

절차

키/값 버전 2 시크릿 엔진을 활성화합니다.

[root@vault ~]# vault secrets enable kv-v2

새 키를 생성합니다.

구문

vault kv put secret/PROJECT_NAME/BUCKET_NAME key=$(openssl rand -base64 32)

예제

[root@vault ~]# vault kv put secret/myproject/mybucketkey key=$(openssl rand -base64 32) ====== Metadata ====== Key Value --- ----- created_time 2020-02-21T17:01:09.095824999Z deletion_time n/a destroyed false version 1

2.12.7. 전송 엔진을 사용하여 키 만들기

Ceph Object Gateway에서 사용할 키를 만들 수 있도록 HCorp Vault Transit 비밀 엔진(전송)을 구성합니다. Ceph Object Gateway로 서버 측 암호화에 사용하려면 Transit 시크릿 엔진을 사용하여 키를 생성할 수 있어야 합니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- HCorp Vault 소프트웨어 설치.

- HseaCorp Vault 노드에 대한 루트 수준 액세스.

절차

Transit 비밀 엔진을 활성화합니다.

[root@vault ~]# vault secrets enable transit

내보내기 가능한 새 키를 생성합니다.

구문

vault write -f transit/keys/BUCKET_NAME exportable=true예제

[root@vault ~]# vault write -f transit/keys/mybucketkey exportable=true

참고기본적으로 위의 명령은

aes256-gcm96유형 키를 생성합니다.키 생성을 확인합니다.

구문

vault read transit/export/encryption-key/BUCKET_NAME/VERSION_NUMBER

예제

[root@vault ~]# vault read transit/export/encryption-key/mybucketkey/1 Key Value --- ----- keys map[1:-gbTI9lNpqv/V/2lDcmH2Nq1xKn6FPDWarCmFM2aNsQ=] name mybucketkey type aes256-gcm96

참고키 버전을 포함한 전체 키 경로를 제공해야 합니다.

2.12.8. AWS 및 Vault를 사용하여 오브젝트 업로드

Ceph Object Gateway에 오브젝트를 업로드할 때 Ceph Object Gateway는 Vault에서 키를 가져온 다음 오브젝트를 암호화하여 버킷에 저장합니다. 오브젝트 다운로드를 요청하면 Ceph Object Gateway에서 Vault에서 해당 키를 자동으로 검색하고 개체의 암호를 해독합니다.

URL은 rgw_crypt_vault_addr 옵션으로 설정된 기본 주소 및 rgw_ crypt_vault_prefix 옵션으로 설정된 경로 접두사를 사용하여 구성됩니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- Ceph Object Gateway 소프트웨어 설치.

- HCorp Vault 소프트웨어 설치.

- Ceph Object Gateway 클라이언트 노드에 액세스합니다.

- AWS(Amazon Web Services) 액세스.

절차

AWS 명령줄 클라이언트를 사용하여 오브젝트를 업로드합니다.

예제

[user@client ~]$ aws --endpoint=http://radosgw:8000 s3 cp plaintext.txt s3://mybucket/encrypted.txt --sse=aws:kms --sse-kms-key-id myproject/mybucketkey

참고예에서 사용된 URL을 가져오는 키는 다음과 같습니다.

http://vault-server:8200/v1/secret/data/myproject/mybucketkey

2.12.9. 추가 리소스

- 자세한 내용은 Vault의 프로젝트 사이트에 대한 Vault 설치 설명서를 참조하십시오.

2.13. 게이트웨이 테스트

REST 인터페이스를 사용하려면 먼저 S3 인터페이스에 대한 초기 Ceph Object Gateway 사용자를 만듭니다. 그런 다음 Swift 인터페이스에 대한 하위 사용자를 만듭니다. 그런 다음 생성된 사용자가 게이트웨이에 액세스할 수 있는지 확인해야 합니다.

2.13.1. S3 사용자 만들기

게이트웨이를 테스트하려면 S3 사용자를 만들고 사용자에게 액세스 권한을 부여합니다. man radosgw-admin 명령은 추가 명령 옵션에 대한 정보를 제공합니다.

다중 사이트 배포에서 master 영역 그룹의 마스터 영역에 항상 호스트에 사용자를 생성합니다.

사전 요구 사항

-

root또는sudo액세스 - Ceph Object Gateway 설치

절차

S3 사용자를 생성합니다.

radosgw-admin user create --uid=name --display-name="First User"name 을 S3 사용자의 이름으로 바꿉니다. 예를 들면 다음과 같습니다.

[root@master-zone]# radosgw-admin user create --uid="testuser" --display-name="First User" { "user_id": "testuser", "display_name": "First User", "email": "", "suspended": 0, "max_buckets": 1000, "auid": 0, "subusers": [], "keys": [ { "user": "testuser", "access_key": "CEP28KDIQXBKU4M15PDC", "secret_key": "MARoio8HFc8JxhEilES3dKFVj8tV3NOOYymihTLO" } ], "swift_keys": [], "caps": [], "op_mask": "read, write, delete", "default_placement": "", "placement_tags": [], "bucket_quota": { "enabled": false, "check_on_raw": false, "max_size": -1, "max_size_kb": 0, "max_objects": -1 }, "user_quota": { "enabled": false, "check_on_raw": false, "max_size": -1, "max_size_kb": 0, "max_objects": -1 }, "temp_url_keys": [], "type": "rgw" }출력을 확인하여

access_key 및값에 JSON 이스케이프 문자(\)가 포함되지 않도록secret_key합니다. 이러한 값은 액세스 검증에 필요하지만 값에 JSON 이스케이프 문자가 포함된 경우 특정 클라이언트는 처리할 수 없습니다. 이 문제를 해결하려면 다음 작업 중 하나를 수행하십시오.- JSON 이스케이프 문자를 제거합니다.

- 문자열을 따옴표로 캡슐화합니다.

- 키를 다시 생성하고 에 JSON 이스케이프 문자가 포함되지 않도록 합니다.

- 키와 시크릿을 수동으로 지정합니다.

유효한 문자이므로 슬래시

/를 제거하지 마십시오.

2.13.2. Swift 사용자 만들기

Swift 인터페이스를 테스트하려면 Swift 하위 사용자를 만듭니다. Swift 사용자를 만드는 작업은 두 단계로 이루어진 프로세스입니다. 첫 번째 단계는 사용자를 만드는 것입니다. 두 번째 단계는 비밀 키를 생성하는 것입니다.

다중 사이트 배포에서 master 영역 그룹의 마스터 영역에 항상 호스트에 사용자를 생성합니다.

사전 요구 사항

- Ceph 개체 게이트웨이 설치.

- Ceph Object Gateway 노드에 대한 루트 수준 액세스.

절차

Swift 사용자를 만듭니다.

구문

radosgw-admin subuser create --uid=NAME --subuser=NAME:swift --access=full

NAME 을 Swift 사용자 이름으로 바꿉니다. 예를 들면 다음과 같습니다.

예제

[root@rgw]# radosgw-admin subuser create --uid=testuser --subuser=testuser:swift --access=full { "user_id": "testuser", "display_name": "First User", "email": "", "suspended": 0, "max_buckets": 1000, "auid": 0, "subusers": [ { "id": "testuser:swift", "permissions": "full-control" } ], "keys": [ { "user": "testuser", "access_key": "O8JDE41XMI74O185EHKD", "secret_key": "i4Au2yxG5wtr1JK01mI8kjJPM93HNAoVWOSTdJd6" } ], "swift_keys": [ { "user": "testuser:swift", "secret_key": "13TLtdEW7bCqgttQgPzxFxziu0AgabtOc6vM8DLA" } ], "caps": [], "op_mask": "read, write, delete", "default_placement": "", "placement_tags": [], "bucket_quota": { "enabled": false, "check_on_raw": false, "max_size": -1, "max_size_kb": 0, "max_objects": -1 }, "user_quota": { "enabled": false, "check_on_raw": false, "max_size": -1, "max_size_kb": 0, "max_objects": -1 }, "temp_url_keys": [], "type": "rgw" }시크릿 키를 생성합니다.

구문

radosgw-admin key create --subuser=NAME:swift --key-type=swift --gen-secretNAME 을 Swift 사용자 이름으로 바꿉니다. 예를 들면 다음과 같습니다.

예제

[root@rgw]# radosgw-admin key create --subuser=testuser:swift --key-type=swift --gen-secret { "user_id": "testuser", "display_name": "First User", "email": "", "suspended": 0, "max_buckets": 1000, "auid": 0, "subusers": [ { "id": "testuser:swift", "permissions": "full-control" } ], "keys": [ { "user": "testuser", "access_key": "O8JDE41XMI74O185EHKD", "secret_key": "i4Au2yxG5wtr1JK01mI8kjJPM93HNAoVWOSTdJd6" } ], "swift_keys": [ { "user": "testuser:swift", "secret_key": "a4ioT4jEP653CDcdU8p4OuhruwABBRZmyNUbnSSt" } ], "caps": [], "op_mask": "read, write, delete", "default_placement": "", "placement_tags": [], "bucket_quota": { "enabled": false, "check_on_raw": false, "max_size": -1, "max_size_kb": 0, "max_objects": -1 }, "user_quota": { "enabled": false, "check_on_raw": false, "max_size": -1, "max_size_kb": 0, "max_objects": -1 }, "temp_url_keys": [], "type": "rgw" }

2.13.3. S3 액세스 테스트

S3 액세스를 확인하기 위해 Python 테스트 스크립트를 작성하고 실행해야 합니다. S3 액세스 테스트 스크립트는 radosgw 에 연결하고 새 버킷을 생성하고 모든 버킷을 나열합니다. aws_access_key_id 및 aws_secret_access_key 의 값은 radosgw key 값에서 가져옵니다.

_admin 명령에서 반환한 access __key 및 secret

출력에 메타데이터를 유지 관리하기 위한 추가 json 필드가 포함되어 있으므로 시스템 사용자에게는 전체 영역에 대한 root 권한이 있어야 합니다.

사전 요구 사항

-

root또는sudo액세스. - Ceph 개체 게이트웨이가 설치되어 있어야 합니다.

- S3 사용자가 생성되었습니다.

절차

Red Hat Enterprise Linux 7용 공통 리포지토리 및 Red Hat Enterprise Linux 8용 High Availability 리포지토리를 활성화합니다.

Red Hat Enterprise Linux 7

# subscription-manager repos --enable=rhel-7-server-rh-common-rpms

Red Hat Enterprise Linux 8

# subscription-manager repos --enable=rhel-8-for-x86_64-highavailability-rpms

python-boto패키지를 설치합니다.Red Hat Enterprise Linux 7

# yum install python-boto

Red Hat Enterprise Linux 8

# dnf install python3-boto3

Python 스크립트를 생성합니다.

vi s3test.py

파일에 다음 내용을 추가합니다.

Red Hat Enterprise Linux 7

import boto import boto.s3.connection access_key = 'ACCESS' secret_key = 'SECRET' boto.config.add_section('s3') conn = boto.connect_s3( aws_access_key_id = access_key, aws_secret_access_key = secret_key, host = 's3.ZONE.hostname', port = PORT, is_secure=False, calling_format = boto.s3.connection.OrdinaryCallingFormat(), ) bucket = conn.create_bucket('my-new-bucket') for bucket in conn.get_all_buckets(): print "{name}\t{created}".format( name = bucket.name, created = bucket.creation_date, )

Red Hat Enterprise Linux 8

import boto3 endpoint = "" # enter the endpoint URL along with the port "http://URL:_PORT_" access_key = 'ACCESS' secret_key = 'SECRET' s3 = boto3.client( 's3', endpoint_url=endpoint, aws_access_key_id=access_key, aws_secret_access_key=secret_key ) s3.create_bucket(Bucket='my-new-bucket') response = s3.list_buckets() for bucket in response['Buckets']: print("{name}\t{created}".format( name = bucket['Name'], created = bucket['CreationDate'] ))

-

ZONE을 게이트웨이 서비스를 구성한 호스트의 영역 이름으로 바꿉니다. 즉게이트웨이 호스트입니다.host'setting이 DNS로 확인되는지 확인합니다. PORT을 게이트웨이의 포트 번호로 바꿉니다. -

ACCESS및SECRET를 Red Hat Ceph Storage 개체 게이트웨이 구성 및 관리 가이드의 S3 사용자 만들기 섹션의accesssecret_key 값으로 바꿉니다._key및

-

스크립트를 실행합니다.

Red Hat Enterprise Linux 7

python s3test.py

Red Hat Enterprise Linux 8

python3 s3test.py

출력 예:

my-new-bucket 2021-08-16T17:09:10.000Z

2.13.4. Swift 액세스 테스트

Swift 액세스는 swift 명령줄 클라이언트를 통해 확인할 수 있습니다. man swift 명령은 사용 가능한 명령줄 옵션에 대한 자세한 정보를 제공합니다.

swift 클라이언트를 설치하려면 다음을 실행합니다.

sudo yum install python-setuptools sudo easy_install pip sudo pip install --upgrade setuptools sudo pip install --upgrade python-swiftclient

swift 액세스를 테스트하려면 다음을 실행합니다.

swift -A http://{IP ADDRESS}:{port}/auth/1.0 -U testuser:swift -K '{swift_secret_key}' list

{IP ADDRESS} 를 게이트웨이 서버의 공용 IP 주소로 바꾸고 {swift_secret_key} 를 swift 사용자에 대해 실행되는 radosgw-admin key create 명령의 값으로 바꿉니다. {port}를 Civetweb으로 사용 중인 포트 번호로 바꿉니다(예: 기본값 8080 ). 포트를 교체하지 않으면 기본값은 포트 80 입니다.

예를 들면 다음과 같습니다.

swift -A http://10.19.143.116:8080/auth/1.0 -U testuser:swift -K '244+fz2gSqoHwR3lYtSbIyomyPHf3i7rgSJrF/IA' list

출력은 다음과 같아야 합니다.

my-new-bucket

2.14. HAProxy/keepalived 구성

Ceph 개체 게이트웨이를 사용하면 부하 증가(즉, 동일한 영역 그룹 및 영역)를 확장할 수 있도록 개체 게이트웨이의 많은 인스턴스를 단일 영역에 할당할 수 있지만 HAProxy/keepalived 를 사용하기 위해 연결된 아키텍처는 필요하지 않습니다. 각 Ceph Object Gateway 인스턴스에는 자체 IP 주소가 있으므로 HAProxy와 keepalived 를 사용하여 Ceph Object Gateway 서버 간 부하를 분산할 수 있습니다.

HAProxy 및 keepalived 의 또 다른 사용 사례는 HAProxy 서버에서 HTTPS를 종료하는 것입니다. HAProxy 서버를 사용하여 HAProxy 서버에서 HTTPS를 종료하고 HAProxy 서버와 Civetweb 게이트웨이 인스턴스 간에 HTTP를 사용할 수 있습니다.

이 섹션에서는 Red Hat Enterprise Linux 7의 HAProxy 및 keepalived 구성에 대해 설명합니다.

Red Hat Enterprise Linux 8의 경우 keepalived 및 haproxy 패키지를 설치하여 로드 밸런서를 설치합니다. Red Hat Enterprise Linux 8에서 부하 분산에 대한 추가 서브스크립션이 필요합니까? 자세한 내용은 기술 자료 문서.

2.14.1. HAProxy/keepalived 사전 요구 사항

Ceph Object Gateway를 사용하여 HA 프록시를 설정하려면 다음을 수행해야 합니다.

- 실행 중인 Ceph 클러스터

-

포트

80에서 실행하도록 구성된 동일한 영역 내의 두 개 이상의 Ceph Object Gateway 서버. 간단한 설치 절차를 따르는 경우 게이트웨이 인스턴스가 기본적으로 동일한 영역 그룹 및 영역에 있습니다. 연결된 아키텍처를 사용하는 경우 인스턴스가 동일한 영역 그룹 및 영역에 있는지 확인합니다. -

HAProxy 및

keepalived용 서버 2대 이상.

이 섹션에서는 두 개 이상의 Ceph Object Gateway 서버가 실행 중이고 포트 80 을 통해 테스트 스크립트를 실행할 때 각 서버에서 유효한 응답을 얻을 수 있다고 가정합니다.

HAProxy 및 keepalived 에 대한 자세한 내용은 부하 분산 관리를 참조하십시오.

2.14.2. HAProxy 노드 준비

다음 설정에서는 haproxy 및 haproxy 2 라는 두 개의 HAProxy 노드와 rgw1 및 라는 Ceph Object Gateway 서버가 있다고 가정합니다. 원하는 모든 이름 지정 규칙을 사용할 수 있습니다. 두 개 이상의 HAProxy 노드에서 다음 절차를 수행합니다.

rgw 2

- Red Hat Enterprise Linux 7 설치.

노드를 등록합니다.

[root@haproxy]# subscription-manager register

RHEL 서버 리포지토리를 활성화합니다.

[root@haproxy]# subscription-manager repos --enable=rhel-7-server-rpms

서버를 업데이트합니다.

[root@haproxy]# yum update -y

-

필요에 따라 관리 도구(예:

wget,vim등)를 설치합니다. 포트

80을 엽니다.[root@haproxy]# firewall-cmd --zone=public --add-port 80/tcp --permanent [root@haproxy]# firewall-cmd --reload

HTTPS의 경우 포트

443을 엽니다.[root@haproxy]# firewall-cmd --zone=public --add-port 443/tcp --permanent [root@haproxy]# firewall-cmd --reload

필수 포트에 연결합니다.

[root@haproxy]# semanage port -m -t http_cache_port_t -p tcp 8081

2.14.3. keepalived 설치 및 구성

두 개 이상의 HAProxy 노드에서 다음 절차를 수행합니다.

사전 요구 사항

- 최소 2개의 HAProxy 노드.

- 최소 두 개의 Object Gateway 노드.

절차

keepalived설치 :[root@haproxy]# yum install -y keepalived

두 HAProxy 노드 모두에서

keepalived를 구성합니다.[root@haproxy]# vim /etc/keepalived/keepalived.conf

구성 파일에는

haproxy프로세스를 확인하는 스크립트가 있습니다.vrrp_script chk_haproxy { script "killall -0 haproxy" # check the haproxy process interval 2 # every 2 seconds weight 2 # add 2 points if OK }다음으로 마스터 및 백업 로드 밸런서의 인스턴스에서

eno1을 네트워크 인터페이스로 사용합니다. 또한 가상 IP 주소 즉,192.168.1.20을 할당합니다.마스터 로드 밸런서 노드

vrrp_instance RGW { state MASTER # might not be necessary. This is on the Master LB node. @main interface eno1 priority 100 advert_int 1 interface eno1 virtual_router_id 50 @main unicast_src_ip 10.8.128.43 80 unicast_peer { 10.8.128.53 } authentication { auth_type PASS auth_pass 1111 } virtual_ipaddress { 192.168.1.20 } track_script { chk_haproxy } } virtual_server 192.168.1.20 80 eno1 { #populate correct interface delay_loop 6 lb_algo wlc lb_kind dr persistence_timeout 600 protocol TCP real_server 10.8.128.43 80 { # ip address of rgw2 on physical interface, haproxy listens here, rgw listens to localhost:8080 or similar weight 100 TCP_CHECK { # perhaps change these to a HTTP/SSL GET? connect_timeout 3 } } real_server 10.8.128.53 80 { # ip address of rgw3 on physical interface, haproxy listens here, rgw listens to localhost:8080 or similar weight 100 TCP_CHECK { # perhaps change these to a HTTP/SSL GET? connect_timeout 3 } } }백업 로드 밸런서 노드

vrrp_instance RGW { state BACKUP # might not be necessary? priority 99 advert_int 1 interface eno1 virtual_router_id 50 unicast_src_ip 10.8.128.53 80 unicast_peer { 10.8.128.43 } authentication { auth_type PASS auth_pass 1111 } virtual_ipaddress { 192.168.1.20 } track_script { chk_haproxy } } virtual_server 192.168.1.20 80 eno1 { #populate correct interface delay_loop 6 lb_algo wlc lb_kind dr persistence_timeout 600 protocol TCP real_server 10.8.128.43 80 { # ip address of rgw2 on physical interface, haproxy listens here, rgw listens to localhost:8080 or similar weight 100 TCP_CHECK { # perhaps change these to a HTTP/SSL GET? connect_timeout 3 } } real_server 10.8.128.53 80 { # ip address of rgw3 on physical interface, haproxy listens here, rgw listens to localhost:8080 or similar weight 100 TCP_CHECK { # perhaps change these to a HTTP/SSL GET? connect_timeout 3 } } }keepalived서비스를 활성화하고 시작합니다.[root@haproxy]# systemctl enable keepalived [root@haproxy]# systemctl start keepalived

추가 리소스

-

keepalived구성에 대한 자세한 내용은 Keepalived를 사용한 초기 로드 밸런서 구성을 참조하십시오.

2.14.4. HAProxy 설치 및 구성

두 개 이상의 HAProxy 노드에서 다음 절차를 수행합니다.

haproxy를 설치합니다.[root@haproxy]# yum install haproxy

SELinux 및 HTTP에 대해

haproxy를 구성합니다.[root@haproxy]# vim /etc/firewalld/services/haproxy-http.xml

다음 행을 추가합니다.

<?xml version="1.0" encoding="utf-8"?> <service> <short>HAProxy-HTTP</short> <description>HAProxy load-balancer</description> <port protocol="tcp" port="80"/> </service>

root로 올바른 SELinux 컨텍스트 및 파일 권한을haproxy-http.xml파일에 할당합니다.[root@haproxy]# cd /etc/firewalld/services [root@haproxy]# restorecon haproxy-http.xml [root@haproxy]# chmod 640 haproxy-http.xml

HTTPS를 사용하려는 경우 SELinux 및 HTTPS에 대해

haproxy를 구성합니다.[root@haproxy]# vim /etc/firewalld/services/haproxy-https.xml

다음 행을 추가합니다.

<?xml version="1.0" encoding="utf-8"?> <service> <short>HAProxy-HTTPS</short> <description>HAProxy load-balancer</description> <port protocol="tcp" port="443"/> </service>

root로 올바른 SELinux 컨텍스트 및 파일 권한을haproxy-https.xml파일에 할당합니다.# cd /etc/firewalld/services # restorecon haproxy-https.xml # chmod 640 haproxy-https.xml

HTTPS를 사용하려는 경우 SSL에 대한 키를 생성합니다. 인증서가 없는 경우 자체 서명된 인증서를 사용할 수 있습니다. 키를 생성하려면 Red Hat Enterprise Linux 7 시스템 관리자 가이드의 새 키 및 인증서 생성을 참조하십시오.

마지막으로 인증서와 키를 PEM 파일에 넣습니다.

[root@haproxy]# cat example.com.crt example.com.key > example.com.pem [root@haproxy]# cp example.com.pem /etc/ssl/private/

haproxy구성.[root@haproxy]# vim /etc/haproxy/haproxy.cfg

global및defaults는 변경되지 않은 상태로 유지될 수 있습니다.defaults섹션을 마치면frontend및backend섹션을 구성해야 합니다. 예를 들면 다음과 같습니다.frontend http_web bind *:80 mode http default_backend rgw frontend rgw-https bind *:443 ssl crt /etc/ssl/private/example.com.pem default_backend rgw backend rgw balance roundrobin mode http server rgw1 10.0.0.71:80 check server rgw2 10.0.0.80:80 checkHAProxy 구성에 대한 자세한 내용은 HAProxy 구성을 참조하십시오.

haproxy활성화/시작[root@haproxy]# systemctl enable haproxy [root@haproxy]# systemctl start haproxy

2.14.5. HAProxy 구성 테스트

HAProxy 노드에서 keepalived 구성의 가상 IP 주소가 표시되는지 확인합니다.

[root@haproxy]# ip addr show

calamari 노드에서 로드 밸런서 구성을 통해 게이트웨이 노드에 연결할 수 있는지 확인합니다. 예를 들면 다음과 같습니다.

[root@haproxy]# wget haproxy

다음과 동일한 결과가 반환되어야 합니다.

[root@haproxy]# wget rgw1

다음 내용이 포함된 index.html 파일을 반환하는 경우:

<?xml version="1.0" encoding="UTF-8"?> <ListAllMyBucketsResult xmlns="http://s3.amazonaws.com/doc/2006-03-01/"> <Owner> <ID>anonymous</ID> <DisplayName></DisplayName> </Owner> <Buckets> </Buckets> </ListAllMyBucketsResult>

그런 다음 구성이 제대로 작동합니다.

2.15. 정적 웹 호스팅의 게이트웨이 구성

기존의 웹 호스팅에는 콘텐츠가 동적으로 변경되지 않을 때 비효율적으로 리소스를 사용할 수 있는 각 웹 사이트에 대한 웹 서버를 설정하는 작업이 포함됩니다. Ceph Object Gateway는 S3 버킷에서 정적 웹 사이트를 호스팅할 수 있습니다.즉, PHP, 서블릿, 데이터베이스, nodejs 등과 같은 서버 측 서비스를 사용하지 않는 사이트입니다. 이 접근 방식은 각 사이트에 대해 웹 서버를 사용하여 VM을 설정하는 것보다 훨씬 더 경제적입니다.

2.15.1. 정적 웹 호스팅 가정

정적 웹 호스팅에는 Ceph Storage Cluster가 하나 이상 실행되고 정적 웹 사이트에는 Ceph Object Gateway 인스턴스가 2개 이상 필요합니다. Red Hat은 각 영역에 HAProxy/keepalived에 의해 여러 게이트웨이 인스턴스의 부하 분산이 있다고 가정합니다.

HAProxy/keepalived 에 대한 자세한 내용은 HAProxy/keepalived 구성을 참조하십시오.

Red Hat 은 Ceph Object Gateway 인스턴스를 사용하여 표준 S3/Swift API와 정적 웹 호스팅을 동시에 배포하는 것을 지원하지 않습니다.

2.15.2. 정적 웹 호스팅 요구 사항

정적 웹 호스팅 기능은 자체 API를 사용하므로 S3 버킷에서 정적 웹 사이트를 사용하도록 게이트웨이를 구성하려면 다음이 필요합니다.

- S3 정적 웹 호스팅에서는 표준 S3/Swift API 사용 사례에 사용되는 인스턴스와 별도의 Ceph Object Gateway 인스턴스를 사용합니다.

- S3 정적 웹 사이트를 호스팅하는 게이트웨이 인스턴스에는 표준 S3/Swift API 게이트웨이 인스턴스와 중복되지 않은 별도의 도메인 이름이 있어야 합니다.

- S3 정적 웹 사이트를 호스팅하는 게이트웨이 인스턴스는 표준 S3/Swift API 게이트웨이 인스턴스에서 별도의 공용 방향 IP 주소를 사용해야 합니다.

- S3 정적 웹 사이트 부하 분산을 호스팅하는 게이트웨이 인스턴스와 필요한 경우 HAProxy/keepalived를 사용하여 SSL을 종료합니다.

2.15.3. 정적 웹 호스팅 게이트웨이 설정

정적 웹 호스팅의 게이트웨이를 활성화하려면 Ceph 구성 파일을 편집하고 다음 설정을 추가합니다.

[client.rgw.<STATIC-SITE-HOSTNAME>] ... rgw_enable_static_website = true rgw_enable_apis = s3, s3website rgw_dns_name = objects-zonegroup.domain.com rgw_dns_s3website_name = objects-website-zonegroup.domain.com rgw_resolve_cname = true ...

rgw_enable_static_website 설정은 true 여야 합니다. rgw_enable_apis 설정은 s3website API를 활성화해야 합니다. rgw_dns_name 및 rgw_dns_s3website_name 설정은 정규화된 도메인을 제공해야 합니다. 사이트에서 정식 이름 확장을 사용하는 경우 rgw_resolve_cname 을 true로 설정합니다.

rgw_dns_name 및 의 FQDN은 중복 되지 않아야 합니다.

rgw_dns _s3website_name

2.15.4. 정적 웹 호스팅 DNS 구성

다음은 가정 DNS 설정의 예입니다. 여기서 처음 두 줄은 표준 S3 인터페이스를 사용하여 게이트웨이 인스턴스의 도메인을 지정하고 각각 IPv4 및 IPv6 주소를 가리킵니다. 세 번째 줄에서는 정식 이름 확장을 사용하여 S3 버킷에 대한 와일드카드 CNAME 설정을 제공합니다. 네 번째 및 다섯 번째 행은 S3 웹사이트 인터페이스를 사용하여 게이트웨이 인스턴스의 도메인을 지정하고 해당 IPv4 및 IPv6 주소를 각각 가리킵니다.

objects-zonegroup.domain.com. IN A 192.0.2.10 objects-zonegroup.domain.com. IN AAAA 2001:DB8::192:0:2:10 *.objects-zonegroup.domain.com. IN CNAME objects-zonegroup.domain.com. objects-website-zonegroup.domain.com. IN A 192.0.2.20 objects-website-zonegroup.domain.com. IN AAAA 2001:DB8::192:0:2:20

처음 두 행의 IP 주소는 네 번째 및 다섯 번째 행의 IP 주소와 다릅니다.

다중 사이트 구성에서 Ceph Object Gateway를 사용하는 경우 라우팅 솔루션을 사용하여 클라이언트와 가장 가까운 게이트웨이로 트래픽을 라우팅하는 것이 좋습니다.

AWS(Amazon Web Service)에는 호스트 이름과 일치하도록 정적 웹 호스트 버킷이 필요합니다. Ceph는 DNS를 구성하는 몇 가지 다른 방법을 제공하며 프록시에 일치하는 인증서가 있는 경우 HTTPS가 작동합니다.

하위 도메인의 버킷에 대한 호스트 이름

AWS 스타일 S3 하위 도메인을 사용하려면 DNS 항목에서 와일드카드를 사용하고 요청을 버킷으로 리디렉션할 수 있습니다. DNS 항목은 다음과 같을 수 있습니다.

*.objects-website-zonegroup.domain.com. IN CNAME objects-website-zonegroup.domain.com.

다음 방식으로 버킷 이름에 액세스합니다.

http://bucket1.objects-website-zonegroup.domain.com

여기서 버킷 이름은 bucket1 입니다.

호스트 이름을 비일치 버킷으로

Ceph에서는 요청에 버킷 이름을 포함하지 않고 Ceph Object Gateway에 고유한 도메인 이름을 버킷에 매핑할 수 있습니다. 도메인 이름을 사용하여 버킷에 액세스하려면 도메인 이름을 버킷 이름에 매핑합니다. DNS 항목은 다음과 같을 수 있습니다.

www.example.com. IN CNAME bucket2.objects-website-zonegroup.domain.com.

버킷 이름이 bucket2인 위치입니다.

다음 방식으로 버킷에 액세스합니다.

http://www.example.com

CNAME을 사용하여 긴 버킷으로 호스트 이름

AWS에는 일반적으로 버킷 이름이 도메인 이름과 일치해야 합니다. CNAME을 사용하여 정적 웹 호스팅을 위해 DNS를 구성하려면 DNS 항목이 다음과 같을 수 있습니다.

www.example.com. IN CNAME www.example.com.objects-website-zonegroup.domain.com.

다음 방식으로 버킷에 액세스합니다.

http://www.example.com

CNAME없이 긴 버킷으로 호스트 이름

DNS 이름에 SOA,NS,MX 또는 TXT 와 같은 CNAME 이외의 다른 레코드가 포함된 경우 DNS 레코드는 도메인 이름을 IP 주소에 직접 매핑해야 합니다. 예를 들면 다음과 같습니다.

www.example.com. IN A 192.0.2.20 www.example.com. IN AAAA 2001:DB8::192:0:2:20

다음 방식으로 버킷에 액세스합니다.

http://www.example.com

2.15.5. 정적 웹 호스팅 사이트 생성

정적 웹 사이트를 생성하려면 다음 단계를 수행합니다.

-

S3 버킷을 생성합니다. 버킷 이름은 웹사이트의 도메인 이름과 같습니다. 예를 들어

mysite.com에는mysite.com의 버킷 이름이 있을 수 있습니다. 이는 AWS에 필요하지만 Ceph에는 필요하지 않습니다. 자세한 내용은 DNS 설정을 참조하십시오. -

정적 웹사이트 콘텐츠를 버킷에 업로드합니다. 콘텐츠에는 HTML, CSS, 클라이언트측 JavaScript, 이미지, 오디오/비디오 콘텐츠 및 기타 다운로드 가능한 파일이 포함될 수 있습니다. 웹 사이트에는

index.html파일이 있고 MAY에는error.html파일이 있어야 합니다. - 웹 사이트의 콘텐츠를 확인합니다. 이때 버킷 생성자만 컨텐츠에 액세스할 수 있습니다.

- 공개적으로 읽을 수 있도록 파일에 대한 권한을 설정합니다.

2.16. 네임스페이스를 NFS-Ganesha로 내보내기

Red Hat Ceph Storage 3 이상에서는 Ceph Object Gateway에서 프로덕션 시스템에 NFS 버전 3 및 NFS 버전 4.1을 사용하여 S3 개체 네임스페이스를 내보낼 수 있는 기능을 제공합니다.

NFS Ganesha 기능은 일반 용도가 아니라 S3 클라우드로만 마이그레이션하는 데만 사용됩니다.

Red Hat Ceph Storage는 NFS 내보내기 버전의 버킷을 지원하지 않습니다.

구현은 UNIX 스타일의 경로 이름을 S3 버킷 및 개체에 매핑하는 AWS(Amazon Web Services) 계층적 네임스페이스 규칙을 준수합니다. NFSv4 의사 루트에 종속되는 연결된 네임스페이스의 최상위 수준은 Ceph Object Gateway S3 버킷으로 구성됩니다. 이 버킷은 NFS 디렉터리로 표시됩니다. 버킷 내의 오브젝트는 S3 규칙에 따라 NFS 파일 및 디렉토리 계층 구조로 제공됩니다. 파일과 디렉토리를 생성하는 작업이 지원됩니다.

하드 또는 소프트 링크 생성 또는 삭제는 지원되지 않습니다. 버킷 또는 디렉토리에서 이름 변경 작업을 수행하는 작업은 NFS를 통해 지원되지 않지만 디렉토리 내에서 또는 파일 시스템과 NFS 마운트 간에 파일 이름 변경이 지원됩니다. NFS를 통해 수행할 때 파일 이름 변경 작업은 대상 디렉터리를 변경하고 일반적으로 전체 readdir 을 새로 고치도록 강제 적용하므로 비용이 더 많이 듭니다.

NFS 마운트를 통해 파일 편집은 지원되지 않습니다.

Ceph 개체 게이트웨이를 사용하려면 애플리케이션이 파일 끝에 0을 순차적으로 기록해야 합니다. 순서가 잘못되면 업로드 작업이 실패합니다. 이 문제를 해결하려면 NFS 공간으로 파일을 복사할 때 cp,cat 또는 rsync 와 같은 유틸리티를 사용하십시오. 항상 동기화 옵션을 사용하여 마운트합니다.

NFS가 포함된 Ceph Object Gateway는 NFS-Ganesha NFS 서버의 프로세스 내 라이브러리 패키징과 NFS-Ganesha NFS 서버의 파일 시스템 추상화 계층(FSAL) 네임스페이스 드라이버를 기반으로 합니다. 런타임 시 NFS가 포함된 Ceph Object Gateway 데몬의 인스턴스는 Civetweb HTTP 서비스가 없는 경우에도 전체 Ceph Object Gateway 데몬을 단일 프로세스로 NFS-Ganesha 인스턴스와 결합합니다. 이 기능을 사용하려면 NFS-Ganesha 버전 2.3.2 이상을 배포합니다.

NFS-Ganesha(nfs-ganesha-rgw ) 인스턴스를 포함할 호스트에서 NFS-Ganesha 인스턴스 시작하기 및 구성의 단계를 수행합니다.

여러 NFS 게이트웨이 실행

각 NFS-Ganesha 인스턴스는 전체 게이트웨이 엔드포인트 역할을 하며, 현재 NFS-Ganesha 인스턴스를 HTTP 서비스를 내보내도록 구성할 수 없는 제한 사항이 있습니다. 일반 게이트웨이 인스턴스와 마찬가지로 여러 NFS-Ganesha 인스턴스를 시작하여 클러스터에서 동일하거나 다른 리소스를 내보낼 수 있습니다. 이렇게 하면 NFS-Ganesha 인스턴스의 클러스터링이 가능합니다. 그러나 고가용성을 의미하는 것은 아닙니다.

일반 게이트웨이 인스턴스와 NFS-Ganesha 인스턴스가 동일한 데이터 리소스가 겹치면 표준 S3 API와 내보낸 NFS-Ganesha 인스턴스를 통해 액세스할 수 있습니다. 동일한 호스트에 Ceph Object Gateway 인스턴스를 사용하여 NFS-Ganesha 인스턴스를 공동 배치할 수 있습니다.

시작하기 전

- NFS-Ganesha 실행을 시도하기 전에 NFS-Ganesha를 실행할 모든 호스트에서 실행 중인 커널 NFS 서비스 인스턴스를 비활성화합니다. 다른 NFS 인스턴스가 실행 중인 경우 NFS-Ganesha가 시작되지 않습니다.

root로 Red Hat Ceph Storage Tools 리포지토리를 활성화합니다.Red Hat Enterprise Linux 7

# subscription-manager repos --enable=rhel-7-server-rhceph-4-tools-rpms

Red Hat Enterprise Linux 8

# subscription-manager repos --enable=rhceph-4-tools-for-rhel-8-x86_64-rpms

rpcbind서비스가 실행 중인지 확인합니다.# systemctl start rpcbind

참고rpcbind를 제공하는rpcbind패키지는 일반적으로 기본적으로 설치됩니다. 그렇지 않은 경우 패키지를 먼저 설치합니다.NFS에서

rpcbind를 사용하는 방법에 대한 자세한 내용은 Red Hat Enterprise Linux 7용 스토리지 관리 가이드의 필수 서비스 섹션을 참조하십시오.nfs-service서비스가 실행 중인 경우 이를 중지하고 비활성화합니다.# systemctl stop nfs-server.service # systemctl disable nfs-server.service

NFS-Ganesha 인스턴스 구성

nfs-ganesha-rgw패키지를 설치합니다.# yum install nfs-ganesha-rgw

Ceph Monitor 노드에서 NFS-Ganesha 호스트의

/etc/ceph/디렉터리에 있는 Ceph 구성 파일을 복사하고 필요에 따라 편집합니다.# scp <mon-host>:/etc/ceph/ceph.conf <nfs-ganesha-rgw-host>:/etc/ceph

참고Ceph 구성 파일에는 유효한

[client.rgw.{instance-name}]섹션과 rgw_data,와 같은 다양한 필수 게이트웨이 구성 변수에 대한 해당 매개 변수가 포함되어야 합니다. 유효한 S3 버킷 명명 요구 사항을 준수하지 않는 Swift 컨테이너를 내보내는 경우 Ceph 구성 파일의keyring또는rgw_frontends[client.rg를w] 섹션에 rgw_relaxed_s3_bucket_namestrue로 설정합니다. 예를 들어 Swift 컨테이너 이름에 밑줄이 포함된 경우 유효한 S3 버킷 이름이 아니며rgw_relaxed_s3_bucket_names가true로 설정되지 않는 한 동기화되지 않습니다. NFS 외부에 개체 및 버킷을 추가하면 해당 오브젝트가rgw_nfs_namespace_expire_secs로 설정된 시간에 NFS 네임스페이스에 표시됩니다. 이 시간은 기본적으로 약 5분입니다. Ceph 구성 파일에서rgw_nfs_namespace_expire_secs의 기본값을 재정의하여 새로 고침 속도를 변경합니다.NFS-Ganesha 구성 파일을 엽니다.

# vim /etc/ganesha/ganesha.conf

FSAL(File System Abstraction Layer) 블록을 사용하여EXPORT섹션을 구성합니다. ID, S3 사용자 ID, S3 액세스 키 및 시크릿을 제공합니다. NFSv4의 경우 다음과 같이 표시됩니다.EXPORT { Export_ID={numeric-id}; Path = "/"; Pseudo = "/"; Access_Type = RW; SecType = "sys"; NFS_Protocols = 4; Transport_Protocols = TCP; Squash = No_Root_Squash; FSAL { Name = RGW; User_Id = {s3-user-id}; Access_Key_Id ="{s3-access-key}"; Secret_Access_Key = "{s3-secret}"; } }Path(경로) 옵션은 Ganesha에 내보내기를 찾을 위치를 지시합니다. VFS FSAL의 경우 서버 네임스페이스 내의 위치입니다. 다른 FSAL의 경우 해당 FSAL 네임스페이스에서 관리하는 파일 시스템 내의 위치일 수 있습니다. 예를 들어 Ceph FSAL을 사용하여 전체 CephFS 볼륨을 내보내는 경우Path는/입니다.Pseudo옵션은 NFS v4의 의사 파일 시스템 네임스페이스에 내보내기를 배치할 위치를 Ganesha에 지시합니다. NFS v4는 서버가 내보내기의 실제 위치에 일치하지 않을 수 있는 의사 네임스페이스를 구성하고 해당 의사 파일 시스템의 일부는 NFS 서버 영역 내에만 존재할 수 있으며 실제 디렉터리에 해당하지 않을 수 있음을 지정합니다. 또한 NFS v4 서버는 모든 내보내기를 단일 네임스페이스에 배치합니다. 단일 내보내기를 의사 파일 시스템 루트로 내보낼 수 있지만, 의사 파일 시스템에 여러 개의 공유디렉토리를 배치하는 것이 훨씬 일반적입니다. 기존 VFS에서는 종종Pseudo위치가경로위치와 동일합니다./를Path(경로)로 사용하고, 여러 공유디렉토리가 필요한 경우 내보내기에는Pseudo옵션과 같은 CephFS 내보내기 예제로 돌아갑니다. 예를 들면/ceph입니다.NFSv3를 지원해야 하는 모든

EXPORT블록에는NFS_Protocols설정에 버전 3이 포함되어야 합니다. 또한 NFSv3는 UDP 전송을 지원하는 마지막 주요 버전입니다. 초기 버전의 표준에는 UDP가 포함되어 있지만 RFC 7530은 사용을 금지합니다. UDP를 활성화하려면Transport_Protocols설정에 포함합니다. 예를 들면 다음과 같습니다.EXPORT { ... NFS_Protocols = 3,4; Transport_Protocols = UDP,TCP; ... }SecType = sys;를 설정하면 Kerberos 인증 없이 클라이언트를 연결할 수 있습니다.Squash = No_Root_Squash;를 설정하면 사용자가 NFS 마운트에서 디렉터리 소유권을 변경할 수 있습니다.기존 OS 네이티브 NFS 4.1 클라이언트를 사용하는 NFS 클라이언트는 일반적으로 대상 서버의

pseudofs루트에서 정의한 내보낸 파일 시스템의 연결된 네임스페이스를 확인합니다. Ceph Object Gateway 내보내기가 있을 수 있습니다.각 공유디렉토리에는

이름,User_Id,Access_Key및Secret_Access_Key라는 자체 표시가 있으며 지정된 사용자에게 표시되는 오브젝트 네임스페이스의 프록시를 생성합니다.내보내기 in

ganesha.conf에는NFSV4블록도 포함할 수 있습니다. Red Hat Ceph Storage는idmapper프로그램을 설정하는 대신Allow_Numeric매개변수를 지원합니다._Owners및 Only_Numberic_OwnersNFSV4 { Allow_Numeric_Owners = true; Only_Numeric_Owners = true; }NFS_CORE_PARAM블록 구성.NFS_CORE_PARAM{ mount_path_pseudo = true; }mount_path_pseudo구성 설정이true로 설정되면 NFS v3 및 NFS v4.x 마운트에서 동일한 서버 측 경로를 사용하여 내보내기에 도달하게 됩니다. 예를 들면 다음과 같습니다.mount -o vers=3 <IP ADDRESS>:/export /mnt mount -o vers=4 <IP ADDRESS>:/export /mntPath Pseudo Tag Mechanism Mount /export/test1 /export/test1 test1 v3 Pseudo mount -o vers=3 server:/export/test1 /export/test1 /export/test1 test1 v3 Tag mount -o vers=3 server:test1 /export/test1 /export/test1 test1 v4 Pseudo mount -o vers=4 server:/export/test1 / /export/ceph1 ceph1 v3 Pseudo mount -o vers=3 server:/export/ceph1 / /export/ceph1 ceph1 v3 Tag mount -o vers=3 server:ceph1 / /export/ceph1 ceph1 v4 Pseudo mount -o vers=4 server:/export/ceph1 / /export/ceph2 ceph2 v3 Pseudo mount -o vers=3 server:/export/ceph2 / /export/ceph2 ceph2 v3 Tag mount -o vers=3 server:ceph2 / /export/ceph2 ceph2 v4 Pseudo mount -o vers=4

mount_path_pseudo구성 설정이false로 설정되면 NFS v3 마운트는Path옵션을 사용하고 NFS v4.x 마운트는Pseudo옵션을 사용합니다.Path Pseudo Tag Mechanism Mount /export/test1 /export/test1 test1 v3 Path mount -o vers=3 server:/export/test1 /export/test1 /export/test1 test1 v3 Tag mount -o vers=3 server:test1 /export/test1 /export/test1 test1 v4 Pseudo mount -o vers=4 server:/export/test1 / /export/ceph1 ceph1 v3 Path mount -o vers=3 server:/ / /export/ceph1 ceph1 v3 Tag mount -o vers=3 server:ceph1 / /export/ceph1 ceph1 v4 Pseudo mount -o vers=4 server:/export/ceph1 / /export/ceph2 ceph2 v3 Path not accessible / /export/ceph2 ceph2 v3 Tag mount -o vers=3 server:ceph2 / /export/ceph2 ceph2 v4 Pseudo mount -o vers=4 server:/export/ceph2

RGW섹션을 구성합니다. 인스턴스 이름을 지정하고, Ceph 구성 파일의 경로를 제공하고, 초기화 인수를 지정합니다.RGW { name = "client.rgw.{instance-name}"; ceph_conf = "/etc/ceph/ceph.conf"; init_args = "--{arg}={arg-value}"; }-

/etc/ganesha/ganesha.conf구성 파일을 저장합니다. nfs-ganesha서비스를 활성화하고 시작합니다.# systemctl enable nfs-ganesha # systemctl start nfs-ganesha

매우 큰 의사 디렉터리의 경우

ceph.conf 파일에서 구성 가능한 매개변수rgw_nfs_s3_fast_attrs를true로 설정하여 네임스페이스를 변경 불가능하고 가속화합니다.rgw_nfs_s3_fast_attrs= true

각 게이트웨이 노드에서 Ceph Object Gateway 서비스를 다시 시작합니다.

# systemctl restart ceph-radosgw.target

NFSv4 클라이언트 구성

네임스페이스에 액세스하려면 구성된 NFS-Ganesha 내보내기를 로컬 POSIX 네임스페이스의 원하는 위치에 마운트합니다. 앞에서 설명했듯이 이 구현에는 다음과 같은 몇 가지 제한 사항이 있습니다.

- NFS 4.1 이상 프로토콜 플레이버만 지원됩니다.

-

쓰기 순서를 적용하려면

sync마운트 옵션을 사용합니다.

NFS-Ganesha 내보내기를 마운트하려면 클라이언트 호스트의 /etc/fstab 파일에 다음 항목을 추가합니다.

<ganesha-host-name>:/ <mount-point> nfs noauto,soft,nfsvers=4.1,sync,proto=tcp 0 0

NFS-Ganesha 호스트 이름과 클라이언트의 마운트 지점의 경로를 지정합니다.

NFS-Ganesha 내보내기를 성공적으로 마운트하려면 클라이언트에 /sbin/mount.nfs 파일이 있어야 합니다. nfs-tools 패키지는 이 파일을 제공합니다. 대부분의 경우 패키지는 기본적으로 설치됩니다. 그러나 nfs-tools 패키지가 클라이언트에 설치되어 있는지 확인하고 그렇지 않은 경우 설치합니다.

NFS에 대한 자세한 내용은 Red Hat Enterprise Linux 7용 스토리지 관리 가이드의 NFS(Network File System) 장을 참조하십시오.

NFSv3 클라이언트 구성

NFSvers =3 및 noacl 을 마운트 옵션으로 제공하여 NFSv3로 마운트하도록 Linux 클라이언트를 구성할 수 있습니다. UDP를 전송으로 사용하려면 proto=udp 를 마운트 옵션에 추가합니다. 그러나 TCP는 기본 프로토콜입니다.

<ganesha-host-name>:/ <mount-point> nfs noauto,noacl,soft,nfsvers=3,sync,proto=tcp 0 0

마운트가 UDP에서 버전 3을 사용하는 경우 버전 3과 UDP를 사용하여 Transports 설정을 사용하여 NFS Ganesha EXPORT 블록 프로토콜 설정을 구성합니다.

NFSv3에서는 클라이언트 OPEN 및 CLOSE 작업을 파일 서버에 통신하지 않으므로 RGW NFS는 이러한 작업을 사용하여 파일 업로드 트랜잭션의 시작과 끝을 표시할 수 없습니다. 대신 RGW NFS는 첫 번째 쓰기가 오프셋 0의 파일로 전송될 때 새 업로드를 시작하려고 시도하고 일정 기간 동안 파일에 대한 새 쓰기가 표시되지 않은 경우 업로드를 완료합니다.기본적으로 10초. 이 값을 변경하려면 Ceph 구성 파일의 RGW 섹션에서 rgw_nfs_write_completion_interval_s 값을 설정합니다.

3장. 관리

관리자는 radosgw-admin 명령줄 인터페이스를 사용하여 Ceph 개체 게이트웨이를 관리할 수 있습니다.

- 관리 데이터 스토리지

- 스토리지 정책

- Indexless Buckets

- 버킷 공유

- 압축

- 사용자 관리

- 할당량 관리

- 사용법

- 버킷 관리

- 버킷 라이프사이클

- Ceph Object Gateway 데이터 레이아웃

- Object Gateway 데이터 레이아웃 매개변수

- STS의 속성 기반 액세스 제어(ABAC)에 대한 세션 태그

- Ceph Object Gateway의 가비지 컬렉션 최적화

- Ceph Object Gateway의 데이터 개체 스토리지 최적화

- Ceph Object Gateway 및 다단계 인증

- Ansible을 사용하여 Ceph Object Gateway 제거

3.1. 관리 데이터 스토리지

Ceph 개체 게이트웨이는 인스턴스의 영역 구성에 정의된 일련의 풀에 관리 데이터를 저장합니다. 예를 들어 이후 섹션에서 설명하는 버킷, 사용자, 사용자 할당량 및 사용 통계는 Ceph Storage 클러스터의 풀에 저장됩니다. 기본적으로 Ceph Object Gateway는 다음 풀을 만들어 기본 영역에 매핑합니다.

-

.rgw.root -

.default.rgw.control -

.default.rgw.meta -

.default.rgw.log -

.default.rgw.buckets.index -

.default.rgw.buckets.data -

.default.rgw.buckets.non-ec

CRUSH 규칙 세트와 배치 그룹 수를 설정할 수 있도록 이러한 풀을 수동으로 생성해야 합니다. 일반적인 구성에서는 Ceph Object Gateway의 관리 데이터를 저장하는 풀에서 동일한 CRUSH 규칙 세트를 사용하는 경우가 많으며 관리 데이터에 대한 풀 10개가 있으므로 배치 그룹의 수가 줄어듭니다. 자세한 내용은 Red Hat Ceph Storage 4에 대한 Pools 및 Storage Strategies 가이드를 참조하십시오.

배치 그룹 계산에 대한 자세한 내용은 풀 계산기당 Ceph 배치 그룹(PG) 을 참조하십시오. mon_pg_warn_max_per_osd 설정은 풀에 너무 많은 배치 그룹을 할당하는 경우 경고합니다(기본값은 300개). 요구 사항 및 하드웨어 기능에 맞게 값을 조정할 수 있습니다. 여기서 n 은 OSD당 최대 PG 수입니다.

mon_pg_warn_max_per_osd = n

3.2. 스토리지 정책 생성

Ceph 개체 게이트웨이는 배치 대상을 식별하고 배치 대상과 연결된 풀에 버킷과 오브젝트를 저장하여 클라이언트 버킷 및 개체 데이터를 저장합니다. 배치 대상을 구성하지 않고 인스턴스의 영역 구성의 풀에 매핑하지 않으면 Ceph Object Gateway는 기본 대상 및 풀(예: default_placement )을 사용합니다.

스토리지 정책을 사용하면 Ceph Object Gateway 클라이언트에 스토리지 전략(예: SSD, SAS 드라이브, SATA 드라이브)을 대상으로 하는 스토리지 전략에 액세스할 수 있습니다. 지속성, 복제, 삭제 코딩 등을 보장하는 특정 방법. 자세한 내용은 Red Hat Ceph Storage 4에 대한 스토리지 전략 가이드를 참조하십시오.

스토리지 정책을 생성하려면 다음 절차를 따르십시오.

-

원하는 스토리지 전략을 사용하여 새 pool

.rgw.buckets.special을 생성합니다. 예를 들어, 삭제 코딩, 특정 CRUSH 규칙 세트, 복제본 수,pg_num 및개수로 사용자 지정된 풀입니다.pgp_num 영역 그룹 구성을 가져와 파일에 저장합니다(예:

zonegroup.json):구문

[root@master-zone]# radosgw-admin zonegroup --rgw-zonegroup=<zonegroup_name> get > zonegroup.json

예제

[root@master-zone]# radosgw-admin zonegroup --rgw-zonegroup=default get > zonegroup.json

zonegroup.json파일의placement_target아래에special-placement항목을 추가합니다.{ "name": "default", "api_name": "", "is_master": "true", "endpoints": [], "hostnames": [], "master_zone": "", "zones": [{ "name": "default", "endpoints": [], "log_meta": "false", "log_data": "false", "bucket_index_max_shards": 11 }], "placement_targets": [{ "name": "default-placement", "tags": [] }, { "name": "special-placement", "tags": [] }], "default_placement": "default-placement" }수정된

zonegroup.json 파일로 영역 그룹을 설정합니다.[root@master-zone]# radosgw-admin zonegroup set < zonegroup.json

영역 구성을 가져와 파일에 저장합니다(예:

zone.json):[root@master-zone]# radosgw-admin zone get > zone.json

영역 파일을 편집하고

placement_pool아래에 새 배치 정책 키를 추가합니다.{ "domain_root": ".rgw", "control_pool": ".rgw.control", "gc_pool": ".rgw.gc", "log_pool": ".log", "intent_log_pool": ".intent-log", "usage_log_pool": ".usage", "user_keys_pool": ".users", "user_email_pool": ".users.email", "user_swift_pool": ".users.swift", "user_uid_pool": ".users.uid", "system_key": { "access_key": "", "secret_key": "" }, "placement_pools": [{ "key": "default-placement", "val": { "index_pool": ".rgw.buckets.index", "data_pool": ".rgw.buckets", "data_extra_pool": ".rgw.buckets.extra" } }, { "key": "special-placement", "val": { "index_pool": ".rgw.buckets.index", "data_pool": ".rgw.buckets.special", "data_extra_pool": ".rgw.buckets.extra" } }] }새 영역 구성을 설정합니다.

[root@master-zone]# radosgw-admin zone set < zone.json

영역 그룹 맵을 업데이트합니다.

[root@master-zone]# radosgw-admin period update --commit

특수 위치 항목은placement_target으로 나열됩니다.

요청 시 스토리지 정책을 지정하려면 다음을 수행합니다.

예제:

$ curl -i http://10.0.0.1/swift/v1/TestContainer/file.txt -X PUT -H "X-Storage-Policy: special-placement" -H "X-Auth-Token: AUTH_rgwtxxxxxx"

3.3. 인덱스 없는 버킷 생성

생성된 버킷을 사용하여 개체 인덱스(즉, 인덱스 없는 버킷)를 저장하는 데 버킷 인덱스를 사용하지 않는 배치 대상을 구성할 수 있습니다. 데이터 복제 또는 목록을 사용하지 않는 배치 대상은 인덱스 없는 버킷을 구현할 수 있습니다. 인덱스리스 버킷은 배치 대상이 특정 버킷의 개체를 추적하지 않는 메커니즘을 제공합니다. 이렇게 하면 오브젝트 쓰기가 발생할 때마다 발생하는 리소스 경합이 제거되고 Ceph Object Gateway가 Ceph 스토리지 클러스터에 생성하는 데 필요한 왕복 횟수를 줄입니다. 이는 동시 작업 및 소규모 오브젝트 쓰기 성능에 긍정적인 영향을 줄 수 있습니다.

인덱싱되지 않은 배치 정책이 있는 버킷에서 작업을 수행할 때 Ceph Object Gateway 데몬이 충돌한다는 것을 확인할 수 있습니다. 따라서 Red Hat은 이 배치 정책을 지정하지 않는 것이 좋습니다.

버킷 인덱스는 버킷의 올바른 상태를 반영하지 않으며 이러한 버킷을 나열하면 해당 오브젝트 목록이 올바르게 반환되지 않습니다. 이는 여러 기능에 영향을 미칩니다. 특히 버킷 인덱스는 변경 정보를 저장하는 데 사용되지 않으므로 이러한 버킷은 다중 영역 환경에서 동기화되지 않습니다. 버킷 인덱스가 이 기능에 필요하므로 S3 개체 버전 관리를 인덱스리스 버킷에 사용하지 않는 것이 좋습니다.

인덱스리스 버킷을 사용하면 단일 버킷에 있는 최대 오브젝트 수 제한이 제거됩니다.

인덱스 없는 버킷의 개체는 NFS에서 나열할 수 없습니다.

사전 요구 사항

- 실행 중이고 정상 상태인 Red Hat Ceph Storage 클러스터.

- Ceph Object Gateway 소프트웨어 설치.

- Ceph Object Gateway 노드에 대한 루트 수준 액세스.

절차

새 배치 대상을 zonegroup에 추가합니다.

예제

[root@rgw ~]# radosgw-admin zonegroup placement add --rgw-zonegroup="default" \ --placement-id="indexless-placement"

새 배치 대상을 영역에 추가합니다.

예제

[root@rgw ~]# radosgw-admin zone placement add --rgw-zone="default" \ --placement-id="indexless-placement" \ --data-pool="default.rgw.buckets.data" \ --index-pool="default.rgw.buckets.index" \ --data_extra_pool="default.rgw.buckets.non-ec" \ --placement-index-type="indexless"

zonegroup의 기본 배치를

indexless-placement로 설정합니다.예제

[root@rgw ~]# radosgw-admin zonegroup placement default --placement-id "indexless-placement"

이 예에서

indexless-placement대상에서 생성된 버킷은 인덱스리스 버킷이 됩니다.클러스터가 다중 사이트 구성에 있는 경우 기간을 업데이트하고 커밋합니다.

예제

[root@rgw ~]# radosgw-admin period update --commit

변경 사항을 적용하려면 Ceph Object Gateway 데몬을 다시 시작합니다.

예제

[root@rgw ~]# systemctl restart ceph-radosgw.target

3.4. 버킷 분할 구성

Ceph 개체 게이트웨이는 버킷 인덱스 데이터를 인덱스 풀(index_pool)에 저장합니다. 기본값은 .rgw.buckets.index 입니다. 클라이언트가 여러 객체를 배치할 때수십만 ~ 수천 개의 객체-버킷당 최대 오브젝트 수에 대한 할당량을 설정하지 않고도 단일 버킷에서 인덱스 풀에 상당한 성능 저하가 발생할 수 있습니다.

버킷 인덱스 분할은 버킷당 많은 객체 수를 허용할 때 성능 병목 현상을 방지하는 데 도움이 됩니다. Red Hat Ceph Storage 4.1부터 기본 버킷 인덱스 shard, bucket_index_max_shards 가 1에서 11로 변경되었습니다. 이러한 변경으로 작은 버킷의 쓰기 처리량이 증가되고 동적 재하이딩이 지연됩니다. 이 변경은 새 버킷과 배포에만 영향을 미칩니다.

Red Hat은 shard 수를 계산된 shard 수에 가장 가까운 정수로 사용할 것을 권장합니다. 소수의 버킷 인덱스 shard는 shard에 버킷 인덱스 항목을 균등하게 분산하는 데 더 효과적입니다. 예를 들어, 이전이 기본이므로 7001 버킷 인덱스 shard가 7000보다 좋습니다.

버킷 인덱스 분할을 구성하려면 다음을 수행합니다.

-

단순한 구성의 새 버킷의 경우

rgw_override_bucket_index_max_shards옵션을 사용하십시오. 보기 3.4.3절. “간단한 구성에서 버킷 인덱스 공유 구성” -

다중 사이트 구성의 새 버킷의 경우

bucket_index_max_shards옵션을 사용합니다. 보기 3.4.4절. “다중 사이트 구성에서 버킷 인덱스 분할 구성”

버킷을 재하드하려면 다음을 수행합니다.

- 동적, 참조 3.4.5절. “동적 버킷 인덱스 복구”

- 수동으로, 참조 3.4.6절. “수동 버킷 인덱스 복구”

- 수동으로 멀티 사이트 구성에서 멀티 사이트에서 수동 Resharding Buckets를참조하십시오.

3.4.1. 버킷 분할 제한

다음 제한 사항을 주의하여 사용하십시오. 하드웨어 선택과 관련된 영향이 있으므로 Red Hat 계정 팀과 항상 이러한 요구 사항을 논의해야 합니다.

분할이 필요하기 전에 하나의 버킷에 있는 최대 오브젝트 수

Red Hat은 버킷 인덱스 shard당 최대 102,400개의 오브젝트를 권장합니다. 분할을 최대한 활용하기 위해 Ceph Object Gateway 버킷 인덱스 풀에 충분한 OSD를 제공하여 최대 병렬 처리를 확보합니다.

Ceph OSD는 현재 인덱싱된 스토리지의 키 범위가 200,000을 초과하는 경우 경고합니다. 결과적으로 shard당 200,000개의 객체 수에 접근하면 이러한 경고를 받게 됩니다. 일부 설정에서는 값이 클 수 있으며 조정 가능합니다.

분할을 사용할 때 최대 오브젝트 수

동적 버킷 재하드를 위한 기본 버킷 인덱스 shard 수는 1999입니다. 이 값은 최대 65521 shard로 변경할 수 있습니다. 1999 버킷 인덱스 shard의 값은 버킷에 204697600 개의 총 개체를 제공하며 65521 샤드 값은 6709350400 개체를 제공합니다.

이전 테스트를 기반으로 현재 지원되는 버킷 인덱스 shard의 최대 수는 65521입니다. Red Hat 품질 보증은 버킷 샤딩에서 전체 확장성 테스트를 수행하지 않았습니다.

버킷 인덱스 shard 수가 1999를 초과하면 일반 S3 클라이언트가 버킷 콘텐츠를 나열하지 못할 수 있습니다. 사용자 정의 클라이언트는 순서가 지정되지 않은 목록을 요청할 수 있습니다. 이 목록은 shard 수로 스케일링됩니다.

3.4.2. 버킷 라이프사이클 병렬 스레드 처리

Red Hat Ceph Storage 4.1의 새로운 기능으로 버킷 라이프사이클의 병렬 스레드 처리를 지원합니다. 이러한 병렬화는 Ceph Object Gateway 인스턴스 수로 확장되며 순서 내 인덱스 shard 열거를 숫자 시퀀스로 대체합니다. 기본 잠금 시간 제한이 60초에서 90초로 연장되었습니다. 각 Ceph Object Gateway 인스턴스에 대해 병렬로 실행되도록 라이프사이클 작업자 스레드를 조정하기 위해 새로운 튜닝 가능 옵션이 추가되었습니다.

rgw_lc_max_worker

이 옵션은 동시에 실행할 라이프사이클 작업자 스레드 수를 지정하므로 버킷과 인덱스 shard를 동시에 처리합니다. rgw_lc_max_worker 옵션의 기본값은 3 입니다.

rgw_lc_max_wp_worker

이 옵션은 각 라이프사이클 작업자의 작업 풀에서 스레드 수를 지정합니다. 이 옵션은 각 버킷을 신속하게 처리하는 데 도움이 될 수 있습니다. rgw_lc_max_wp_worker 옵션의 기본값은 3 입니다.

추가 리소스

- 자세한 내용은 Red Hat Ceph Storage 구성 가이드의 Ceph 구성파일 섹션을 참조하십시오.

3.4.3. 간단한 구성에서 버킷 인덱스 공유 구성

모든 새 버킷에서 버킷 인덱스 분할을 활성화하고 구성하려면 rgw_override_bucket_index_max_shards 매개변수를 사용합니다. 매개변수를 다음과 같이 설정합니다.

-

버킷 인덱스 분할을 비활성화하려면

0입니다. 이는 기본값입니다. -

버킷 샤딩을 활성화하고 최대 shard 수를 설정하는

0보다 큰 값입니다.

사전 요구 사항

절차

권장 shard 수를 계산합니다. 이렇게 하려면 다음 공식을 사용하십시오.

number of objects expected in a bucket / 100,000

최대 shard 수는 65521입니다.

rgw_override_bucket_index_max_shards를 Ceph 구성 파일에 추가합니다.rgw_override_bucket_index_max_shards = value값을 이전 단계에서 계산한 권장 shard 수로 바꿉니다. 예를 들면 다음과 같습니다.

rgw_override_bucket_index_max_shards = 12

-

Ceph Object Gateway의 모든 인스턴스에 대한 버킷 인덱스 분할을 구성하려면

[global]섹션에rgw_override_bucket_index_max_shards를 추가합니다. -

Ceph Object Gateway의 특정 인스턴스에 대해서만 버킷 인덱스 분할을 구성하려면 인스턴스에

rgw_override_bucket_index_max_shards를 추가합니다.

-

Ceph Object Gateway의 모든 인스턴스에 대한 버킷 인덱스 분할을 구성하려면

Ceph Object Gateway를 다시 시작합니다.

# systemctl restart ceph-radosgw.target

추가 리소스

3.4.4. 다중 사이트 구성에서 버킷 인덱스 분할 구성

다중 사이트 구성에서 각 영역에 다른 index_pool 설정이 있어 장애 조치(failover)를 관리할 수 있습니다. 하나의 영역 그룹에서 영역에 대한 일관된 shard 수를 구성하려면 해당 영역 그룹의 구성에서 bucket_index_max_shards 설정을 설정합니다. 매개변수를 다음과 같이 설정합니다.

매개변수를 다음과 같이 설정합니다.

-

0버킷 인덱스 샤딩을 비활성화하려면 기본값bucket_index_max_shards는11입니다. -

버킷 샤딩을 활성화하고 최대 shard 수를 설정하는

0보다 큰 값입니다.

인덱스 풀(해당되는 경우)을 SSD 기반 OSD의 CRUSH 규칙 세트에 매핑하면 버킷 인덱스 성능도 도움이 될 수 있습니다.

사전 요구 사항

절차

권장 shard 수를 계산합니다. 이렇게 하려면 다음 공식을 사용하십시오.

number of objects expected in a bucket / 100,000

최대 shard 수는 65521입니다.

영역 그룹 구성을

zonegroup.json파일로 추출합니다.$ radosgw-admin zonegroup get > zonegroup.json

zonegroup.json파일에서 명명된 각 영역에 대해bucket_index_max_shards설정을 설정합니다.bucket_index_max_shards = VALUE값을 이전 단계에서 계산한 권장 shard 수로 바꿉니다. 예를 들면 다음과 같습니다.

bucket_index_max_shards = 12

영역 그룹을 재설정합니다.

$ radosgw-admin zonegroup set < zonegroup.json

기간을 업데이트합니다.

$ radosgw-admin period update --commit

추가 리소스

3.4.5. 동적 버킷 인덱스 복구

동적 버킷 재하드 프로세스에서는 모든 Ceph Object Gateway 버킷을 정기적으로 확인하고 재하이드가 필요한 버킷을 탐지합니다. rgw_max_objs_per_shard 매개변수에 지정된 값보다 버킷이 커지면 Ceph Object Gateway에서 버킷을 백그라운드에서 동적으로 다시 작성합니다. rgw_max_objs_per_shard 의 기본값은 shard당 100k 오브젝트입니다.

기본값은 회전 디스크에 저장된 버킷 인덱스 경험을 기반으로 합니다. 플래시 미디어에서 버킷 인덱스를 사용하는 최신 설정에서 버킷 인덱스 shard당 최대 개체의 값이 높을 수 있습니다.

동적 버킷 인덱스가 업그레이드된 단일 사이트 구성에서 영역 또는 영역 그룹을 변경하지 않고 예상대로 작동합니다. 단일 사이트 구성 요소는 다음 중 하나일 수 있습니다.

- 영역이 없는 기본 영역 구성입니다.

- 하나 이상의 영역이 있는 기본이 아닌 구성입니다.

- 다중 실제 단일 사이트 구성.

사전 요구 사항

절차

동적 버킷 인덱스 재하드를 활성화하려면 다음을 수행합니다.

-

Ceph 구성 파일의

rgw_dynamic_resharding설정을 기본값인true로 설정합니다. 선택사항입니다. 필요한 경우 Ceph 구성 파일에서 다음 매개변수를 변경합니다.

-

rgw_reshard_num_logs: 재하드 로그의 shard 수입니다. 기본값은16입니다. -

rgw_reshard_bucket_lock_duration: 재하드 중에 버킷의 잠금 기간입니다. 기본값은360초입니다. -

rgw_dynamic_resharding: 동적 재하드를 활성화 또는 비활성화합니다. 기본값은true입니다. -

rgw_max_objs_per_shard: shard당 최대 오브젝트 수입니다. 기본값은 shard당100000개 오브젝트입니다. -

rgw_reshard_thread_interval: reshard 스레드 처리 사이의 최대 시간. 기본값은600초입니다.

-

-

Ceph 구성 파일의

resharding 큐에 버킷을 추가하려면 다음을 수행합니다.

radosgw-admin reshard add --bucket bucket --num-shards number

교체:

- 재 하드 할 버킷의 이름이 있는 버킷

- 새 shard 수가 있는 숫자

예를 들면 다음과 같습니다.

$ radosgw-admin reshard add --bucket data --num-shards 10

resharding 큐를 나열하려면 다음을 수행합니다.

$ radosgw-admin reshard list

버킷 재하드 상태를 확인하려면 다음을 수행합니다.

radosgw-admin reshard status --bucket bucket교체:

- 재 하드 할 버킷의 이름이 있는 버킷

예를 들면 다음과 같습니다.

$ radosgw-admin reshard status --bucket data

Resharding queue에서 즉시 항목을 처리하려면 다음을 수행합니다.

$ radosgw-admin reshard process

보류 중인 버킷 재하드를 취소하려면 다음을 수행합니다.

radosgw-admin reshard cancel --bucket bucket교체:

- 보류 중인 버킷 의 이름으로 버킷

예를 들면 다음과 같습니다.

$ radosgw-admin reshard cancel --bucket data

중요보류 중인 재하드 작업만 취소할 수 있습니다. 진행 중인 재하드 작업을 취소하지 마십시오.

- Red Hat Ceph Storage 3.1 및 이전 버전을 사용하는 경우 Re sharding(기존 인스턴스 정리) 섹션에 설명된 대로 오래된 버킷 항목을 제거합니다.

3.4.6. 수동 버킷 인덱스 복구

버킷이 초기 구성보다 커진 경우 radosgw-admin 버킷 reshard 명령을 사용하여 버킷 인덱스 풀을 다시 작성합니다. 이 명령은 다음과 같습니다.

- 지정된 버킷에 대한 새 버킷 인덱스 오브젝트 세트를 생성합니다.

- 이러한 버킷 인덱스 오브젝트에 오브젝트 항목을 배포합니다.

- 새 버킷 인스턴스를 만듭니다.

- 모든 새 인덱스 작업이 새 버킷 인덱스를 통과하도록 새 버킷 인스턴스를 버킷에 연결합니다.

- 이전 및 새 버킷 ID를 명령 출력에 출력합니다.

이 절차는 간단한 구성에서만 사용하십시오. 다중 사이트 구성에서 버킷을 재하드하려면 멀티사이트 를 사용하여 버킷 수동 복구를 참조하십시오.

사전 요구 사항

절차

원래 버킷 인덱스를 백업합니다.

radosgw-admin bi list --bucket=bucket > bucket.list.backup

교체:

- 재 하드 할 버킷의 이름이 있는 버킷

예를 들어

data라는 버킷의 경우 다음을 입력합니다.$ radosgw-admin bi list --bucket=data > data.list.backup

버킷 인덱스를 다시 작성합니다.

radosgw-admin bucket reshard --bucket=bucket --num-shards=number

교체:

- 재 하드 할 버킷의 이름이 있는 버킷

- 새 shard 수가 있는 숫자

예를 들어

data라는 버킷과 필요한 shard 수가 100인 경우 다음을 입력합니다.$ radosgw-admin bucket reshard --bucket=data --num-shards=100

- Red Hat Ceph Storage 3.1 및 이전 버전을 사용하는 경우 Re sharding(기존 인스턴스 정리) 섹션에 설명된 대로 오래된 버킷 항목을 제거합니다.

3.4.7. 복구 후 오래된 인스턴스 정리

Red Hat Ceph Storage 3.1 및 이전 버전에서는 resharding 프로세스가 오래된 버킷 항목 인스턴스를 자동으로 정리하지 않습니다. 이러한 오래된 인스턴스는 수동으로 정리되지 않은 경우 클러스터의 성능에 영향을 줄 수 있습니다.

다중 사이트 클러스터에서는 이 절차를 단순한 구성에서만 사용하십시오.

사전 요구 사항

- Ceph 개체 게이트웨이가 설치되어 있어야 합니다.

절차

오래된 인스턴스를 나열합니다.

$ radosgw-admin reshard stale-instances list

오래된 인스턴스를 정리합니다.

$ radosgw-admin reshard stale-instances rm

3.5. 압축 활성화

Ceph Object Gateway는 Ceph의 압축 플러그인을 사용하여 업로드된 오브젝트의 서버 측 압축을 지원합니다. 여기에는 다음이 포함됩니다.

-

zlib: 지원됨. -

snappy: 기술 프리뷰. -

zstd: 기술 프리뷰.

snappy 및 zstd 압축 플러그인은 기술 프리뷰 기능이므로 Red Hat은 아직 품질 보증 테스트를 완료하지 않았기 때문에 완벽하게 지원되지 않습니다.

설정

영역의 배치 대상에서 압축을 활성화하려면 radosgw-admin 영역 배치 수정 명령에 --compression=<type> 옵션을 제공합니다. 압축 유형은 새 오브젝트 데이터를 작성할 때 사용할 압축 플러그인의 이름을 나타냅니다.

각 압축 오브젝트는 압축 유형을 저장합니다. 설정을 변경해도 기존 압축 오브젝트의 압축을 해제하는 기능도 저하되지 않으며, Ceph Object Gateway에서 기존 개체의 압축을 다시 풉니다.

이 압축 설정은 이 배치 대상을 사용하여 버킷에 업로드된 모든 새 개체에 적용됩니다.

영역의 배치 대상에서 압축을 비활성화하려면 radosgw-admin 영역 배치 수정 명령에 --compression=<type> 옵션을 제공하고 빈 문자열 또는 none 을 지정합니다.

예를 들면 다음과 같습니다.

$ radosgw-admin zone placement modify --rgw-zone=default --placement-id=default-placement --compression=zlib

{

...

"placement_pools": [

{

"key": "default-placement",

"val": {

"index_pool": "default.rgw.buckets.index",

"data_pool": "default.rgw.buckets.data",

"data_extra_pool": "default.rgw.buckets.non-ec",

"index_type": 0,

"compression": "zlib"

}

}

],

...

}압축을 활성화하거나 비활성화한 후 Ceph Object Gateway 인스턴스를 다시 시작하여 변경 사항이 적용됩니다.

Ceph Object Gateway는 기본 영역과 풀 세트를 만듭니다. 프로덕션 배포의 경우 프로덕션 용 Ceph Object Gateway 가이드, 보다 구체적으로는 Realm 생성 섹션을 참조하십시오. 다중 사이트 도 참조하십시오.

통계

모든 기존 명령 및 API는 압축되지 않은 데이터를 기반으로 개체 및 버킷 크기를 계속 보고하지만 radosgw-admin 버킷 stats 명령에는 지정된 버킷에 대한 압축 통계가 포함됩니다.

$ radosgw-admin bucket stats --bucket=<name>

{

...

"usage": {

"rgw.main": {

"size": 1075028,

"size_actual": 1331200,

"size_utilized": 592035,

"size_kb": 1050,

"size_kb_actual": 1300,

"size_kb_utilized": 579,

"num_objects": 104

}

},

...

}

size_utilized 및 size_kb_utilized 필드는 각각 바이트와 킬로바이트 단위로 압축 데이터의 총 크기를 나타냅니다.

3.6. 사용자 관리

Ceph Object Storage 사용자 관리는 Ceph Storage 클러스터의 클라이언트 애플리케이션으로 Ceph Object Gateway가 아닌 Ceph Object Storage 서비스의 클라이언트 애플리케이션인 사용자를 나타냅니다. 클라이언트 애플리케이션이 Ceph Object Gateway 서비스와 상호 작용할 수 있도록 사용자를 생성하고 키 및 시크릿에 액세스해야 합니다.

다음 두 가지 사용자 유형이 있습니다.

- 사용자: 'user'라는 용어는 S3 인터페이스의 사용자를 반영합니다.

- 하위 사용자: 'subuser'라는 용어는 Swift 인터페이스의 사용자를 반영합니다. 하위 사용자는 사용자와 연결됩니다.

사용자와 하위 사용자를 생성, 수정, 보기, 일시 중단 및 제거할 수 있습니다.

다중 사이트 배포에서 사용자를 관리하는 경우 ALWAYS는 사용자가 master 영역 그룹의 마스터 영역 내의 Ceph Object Gateway 노드에서 radosgw-admin 명령을 실행하여 사용자가 다중 사이트 클러스터 전체에서 동기화되도록 합니다. 보조 영역 또는 보조 영역 그룹에서 다중 사이트 클러스터에서 사용자를 생성, 수정 또는 삭제하지 마십시오. 이 문서에서는 [root@master-zone]# 을 마스터 영역 그룹의 마스터 영역에 있는 호스트에 대한 명령줄 규칙으로 사용합니다.

사용자 및 하위 사용자 ID를 만드는 것 외에도 사용자의 표시 이름과 이메일 주소를 추가할 수 있습니다. 키와 시크릿을 지정하거나 키와 시크릿을 자동으로 생성할 수 있습니다. 키를 생성하거나 지정할 때 사용자 ID는 S3 키 유형에 해당하고 하위 사용자 ID는 swift 키 유형에 해당합니다. Swift 키에는 읽기,, 쓰기, 읽기전체 의 액세스 수준도 있습니다.

사용자 관리 명령줄 구문은 일반적으로 user <command> <user-id> 패턴을 따릅니다. 여기서 <user-id> 는 --uid= 옵션 다음에 사용자 ID(S3) 또는 --subuser= 옵션 뒤에 사용자 이름(Swift)이 옵니다. 예를 들면 다음과 같습니다.

[root@master-zone]# radosgw-admin user <create|modify|info|rm|suspend|enable|check|stats> <--uid={id}|--subuser={name}> [other-options]실행하는 명령에 따라 추가 옵션이 필요할 수도 있습니다.

3.6.1. 멀티 테넌시

Red Hat Ceph Storage 2 이상에서 Ceph Object Gateway는 S3 및 Swift API 모두에 대해 멀티 테넌시를 지원합니다. 여기서 각 사용자 및 버킷은 "테넌트"에 있습니다. 멀티 테넌시는 여러 테넌트가 "테스트", "main" 등과 같은 일반적인 버킷 이름을 사용할 때 네임스페이스 충돌을 방지합니다.

각 사용자 및 버킷은 테넌트 아래에 있습니다. 이전 버전과의 호환성을 위해 이름이 비어 있는 "기존" 테넌트가 추가됩니다. 특히 테넌트를 지정하지 않고 버킷을 참조할 때마다 Swift API는 "기존" 테넌트를 가정합니다. 기존 사용자는 또한 레거시 테넌트 아래에 저장되므로 이전 릴리스와 동일한 방식으로 버킷 및 개체에 액세스합니다.

따라서 테넌트에는 어떤 작업도 없습니다. 사용자를 관리할 때 필요에 따라 표시 및 사라집니다. 명시적 테넌트가 있는 사용자를 생성, 수정 및 제거하려면 추가 옵션 --tenant 이 제공되거나 radosgw-admin 명령의 매개 변수에 "<tenant>$<user>" 구문을 사용합니다.

S3에 대한 testx$tester 사용자를 만들려면 다음을 실행합니다.

[root@master-zone]# radosgw-admin --tenant testx --uid tester \

--display-name "Test User" --access_key TESTER \

--secret test123 user create

Swift에 대한 testx$tester 사용자를 만들려면 다음 중 하나를 실행합니다.

[root@master-zone]# radosgw-admin --tenant testx --uid tester \

--display-name "Test User" --subuser tester:swift \

--key-type swift --access full subuser create

[root@master-zone]# radosgw-admin key create --subuser 'testx$tester:swift' \

--key-type swift --secret test123명시적 테넌트가 있는 하위 사용자를 쉘에 따옴표로 묶어야 합니다.

3.6.2. 사용자 만들기

user create 명령을 사용하여 S3-interface 사용자를 생성합니다. 사용자 ID와 표시 이름을 지정해야 합니다. 이메일 주소도 지정할 수 있습니다. 키 또는 시크릿을 지정하지 않으면 radosgw-admin 이 자동으로 생성됩니다. 그러나 생성된 키/시크릿 쌍을 사용하지 않으려면 키 및/또는 시크릿을 지정할 수 있습니다.

[root@master-zone]# radosgw-admin user create --uid=<id> \ [--key-type=<type>] [--gen-access-key|--access-key=<key>]\ [--gen-secret | --secret=<key>] \ [--email=<email>] --display-name=<name>

예를 들면 다음과 같습니다.

[root@master-zone]# radosgw-admin user create --uid=janedoe --display-name="Jane Doe" --email=jane@example.com

{ "user_id": "janedoe",

"display_name": "Jane Doe",

"email": "jane@example.com",

"suspended": 0,

"max_buckets": 1000,

"auid": 0,

"subusers": [],

"keys": [

{ "user": "janedoe",

"access_key": "11BS02LGFB6AL6H1ADMW",

"secret_key": "vzCEkuryfn060dfee4fgQPqFrncKEIkh3ZcdOANY"}],

"swift_keys": [],

"caps": [],

"op_mask": "read, write, delete",

"default_placement": "",

"placement_tags": [],

"bucket_quota": { "enabled": false,

"max_size_kb": -1,

"max_objects": -1},

"user_quota": { "enabled": false,

"max_size_kb": -1,

"max_objects": -1},

"temp_url_keys": []}

키 출력을 확인합니다. 경우에 따라 radosgw-admin 이 JSON 이스케이프(\)문자를생성하며 일부 클라이언트는 JSON 이스케이프 문자를 처리하는 방법을 모르는 경우가 있습니다. 해결 방법에는 JSON 이스케이프 문자(\)를 제거하고 문자열을 따옴표로 캡슐화하여 키를 다시 생성하고 JSON 이스케이프 문자가 없는지 확인하거나 키와 시크릿을 수동으로 지정하는 작업이 포함됩니다.

3.6.3. 하위 사용자 만들기

하위 사용자(Swift 인터페이스)를 만들려면 사용자 ID(--uid={username}), 하위 사용자 ID 및 하위 사용자의 액세스 수준을 지정해야 합니다. 키 또는 시크릿을 지정하지 않으면 radosgw-admin 이 자동으로 생성됩니다. 그러나 생성된 키/시크릿 쌍을 사용하지 않으려면 키 및/또는 시크릿을 지정할 수 있습니다.

full 에도 액세스 제어 정책이 포함되어 있으므로 full는 읽기 가 아닙니다.

[root@master-zone]# radosgw-admin subuser create --uid={uid} --subuser={uid} --access=[ read | write | readwrite | full ]예를 들면 다음과 같습니다.

[root@master-zone]# radosgw-admin subuser create --uid=janedoe --subuser=janedoe:swift --access=full

{ "user_id": "janedoe",

"display_name": "Jane Doe",

"email": "jane@example.com",

"suspended": 0,

"max_buckets": 1000,

"auid": 0,

"subusers": [

{ "id": "janedoe:swift",

"permissions": "full-control"}],

"keys": [

{ "user": "janedoe",

"access_key": "11BS02LGFB6AL6H1ADMW",

"secret_key": "vzCEkuryfn060dfee4fgQPqFrncKEIkh3ZcdOANY"}],

"swift_keys": [],

"caps": [],

"op_mask": "read, write, delete",

"default_placement": "",

"placement_tags": [],

"bucket_quota": { "enabled": false,

"max_size_kb": -1,

"max_objects": -1},

"user_quota": { "enabled": false,

"max_size_kb": -1,

"max_objects": -1},

"temp_url_keys": []}3.6.4. 사용자 정보 가져오기

사용자에 대한 정보를 얻으려면 사용자 정보와 사용자 ID(--uid={username})를 지정합니다.

[root@master-zone]# radosgw-admin user info --uid=janedoe

테넌트된 사용자에 대한 정보를 얻으려면 사용자 ID와 테넌트의 이름을 둘 다 지정합니다.

[root@master-zone]# radosgw-admin user info --uid=janedoe --tenant=test

3.6.5. 사용자 정보 수정

사용자에 대한 정보를 수정하려면 사용자 ID(--uid={username})와 수정할 속성을 지정해야 합니다. 일반적인 수정 사항은 키와 시크릿, 이메일 주소, 표시 이름 및 액세스 수준입니다. 예를 들면 다음과 같습니다.

[root@master-zone]# radosgw-admin user modify --uid=janedoe --display-name="Jane E. Doe"

하위 사용자 값을 수정하려면 하위 사용자 수정 및 하위 사용자 ID를 지정합니다. 예를 들면 다음과 같습니다.

[root@master-zone]# radosgw-admin subuser modify --subuser=janedoe:swift --access=full

3.6.6. 사용자 활성화 및 일시 중지

사용자를 생성하면 기본적으로 사용자가 활성화됩니다. 그러나 사용자 권한을 중지하고 나중에 다시 활성화할 수 있습니다. 사용자를 일시 중단하려면 사용자 일시 중지 및 사용자 ID를 지정합니다.

[root@master-zone]# radosgw-admin user suspend --uid=johndoe

일시 중단된 사용자를 다시 활성화하려면 user enable 및 user ID를 지정합니다. :

[root@master-zone]# radosgw-admin user enable --uid=johndoe

사용자를 비활성화하면 하위 사용자가 비활성화됩니다.

3.6.7. 사용자 제거

사용자를 제거하면 사용자와 하위 사용자가 시스템에서 제거됩니다. 그러나 원하는 경우 하위 사용자만 제거할 수 있습니다. 사용자(및 하위 사용자)를 제거하려면 사용자 rm 과 사용자 ID를 지정합니다.

[root@master-zone]# radosgw-admin user rm --uid=<uid> [--purge-keys] [--purge-data]

예를 들면 다음과 같습니다.

[root@master-zone]# radosgw-admin user rm --uid=johndoe --purge-data

하위 사용자만 제거하려면 subuser rm 및 subuser 이름을 지정합니다.

[root@master-zone]# radosgw-admin subuser rm --subuser=johndoe:swift --purge-keys

옵션은 다음과 같습니다.

-

데이터 삭제: purge

-data옵션은 UID와 연결된 모든 데이터를 삭제합니다. -

키 삭제: purge

-keys옵션은 UID와 연결된 모든 키를 제거합니다.

3.6.8. 하위 사용자 제거

하위 사용자를 제거하면 Swift 인터페이스에 대한 액세스를 제거합니다. 사용자는 시스템에 남아 있게 됩니다. Ceph Object Gateway(오브젝트 게이트웨이) 하위 사용자를 제거하려면 subuser rm 및 subuser ID를 지정합니다.

[root@master-zone]# radosgw-admin subuser rm --subuser=johndoe:test

옵션은 다음과 같습니다.

-

키 삭제: purge

-keys옵션은 UID와 연결된 모든 키를 제거합니다.

3.6.9. 사용자 이름 변경

사용자의 이름을 변경하려면 radosgw-admin 사용자 rename 명령을 사용합니다. 이 명령이 사용하는 시간은 사용자가 보유한 버킷 및 오브젝트 수에 따라 다릅니다. 숫자가 크면 screen 패키지에서 제공하는 Screen 유틸리티에서 명령을 사용하는 것이 좋습니다.

사전 요구 사항

- 작동 중인 Ceph 클러스터

-

root또는sudo액세스 - 설치된 Ceph Object Gateway

절차

사용자 이름을 변경합니다.

radosgw-admin user rename --uid=current-user-name --new-uid=new-user-name

예를 들어

user1의 이름을 user2로 변경하려면 다음을 수행합니다.# radosgw-admin user rename --uid=user1 --new-uid=user2 { "user_id": "user2", "display_name": "user 2", "email": "", "suspended": 0, "max_buckets": 1000, "auid": 0, "subusers": [], "keys": [ { "user": "user2", "access_key": "59EKHI6AI9F8WOW8JQZJ", "secret_key": "XH0uY3rKCUcuL73X0ftjXbZqUbk0cavD11rD8MsA" } ], "swift_keys": [], "caps": [], "op_mask": "read, write, delete", "default_placement": "", "placement_tags": [], "bucket_quota": { "enabled": false, "check_on_raw": false, "max_size": -1, "max_size_kb": 0, "max_objects": -1 }, "user_quota": { "enabled": false, "check_on_raw": false, "max_size": -1, "max_size_kb": 0, "max_objects": -1 }, "temp_url_keys": [], "type": "rgw" }사용자가 테넌트 내에 있는 경우 사용자 이름과 테넌트를 둘 다 지정합니다.

구문

radosgw-admin user rename --uid user-name --new-uid new-user-name --tenant tenant

예를 들어

테스트테넌트 내에서user1의 이름을user2로 변경하려면 다음을 수행합니다.예제

# radosgw-admin user rename --uid=test$user1 --new-uid=test$user2 --tenant test 1000 objects processed in tvtester1. Next marker 80_tVtester1_99 2000 objects processed in tvtester1. Next marker 64_tVtester1_44 3000 objects processed in tvtester1. Next marker 48_tVtester1_28 4000 objects processed in tvtester1. Next marker 2_tVtester1_74 5000 objects processed in tvtester1. Next marker 14_tVtester1_53 6000 objects processed in tvtester1. Next marker 87_tVtester1_61 7000 objects processed in tvtester1. Next marker 6_tVtester1_57 8000 objects processed in tvtester1. Next marker 52_tVtester1_91 9000 objects processed in tvtester1. Next marker 34_tVtester1_74 9900 objects processed in tvtester1. Next marker 9_tVtester1_95 1000 objects processed in tvtester2. Next marker 82_tVtester2_93 2000 objects processed in tvtester2. Next marker 64_tVtester2_9 3000 objects processed in tvtester2. Next marker 48_tVtester2_22 4000 objects processed in tvtester2. Next marker 32_tVtester2_42 5000 objects processed in tvtester2. Next marker 16_tVtester2_36 6000 objects processed in tvtester2. Next marker 89_tVtester2_46 7000 objects processed in tvtester2. Next marker 70_tVtester2_78 8000 objects processed in tvtester2. Next marker 51_tVtester2_41 9000 objects processed in tvtester2. Next marker 33_tVtester2_32 9900 objects processed in tvtester2. Next marker 9_tVtester2_83 { "user_id": "test$user2", "display_name": "User 2", "email": "", "suspended": 0, "max_buckets": 1000, "auid": 0, "subusers": [], "keys": [ { "user": "test$user2", "access_key": "user2", "secret_key": "123456789" } ], "swift_keys": [], "caps": [], "op_mask": "read, write, delete", "default_placement": "", "placement_tags": [], "bucket_quota": { "enabled": false, "check_on_raw": false, "max_size": -1, "max_size_kb": 0, "max_objects": -1 }, "user_quota": { "enabled": false, "check_on_raw": false, "max_size": -1, "max_size_kb": 0, "max_objects": -1 }, "temp_url_keys": [], "type": "rgw" }사용자의 이름이 성공적으로 변경되었는지 확인합니다.

구문

radosgw-admin user info --uid=new-user-name예를 들면 다음과 같습니다.

예제

# radosgw-admin user info --uid=user2

사용자가 테넌트 내에 있는 경우 테넌트$사용자 이름 형식을 사용하십시오.

radosgw-admin user info --uid=tenant$new-user-name

# radosgw-admin user info --uid=test$user2

추가 리소스

-

screen(1)매뉴얼 페이지

3.6.10. 키 만들기

사용자에 대한 키를 생성하려면 키 생성을 지정해야 합니다. 사용자의 경우 사용자 ID 및 s3 키 유형을 지정합니다. 하위 사용자에 대한 키를 만들려면 하위 사용자 ID와 swift 키 유형을 지정해야 합니다. 예를 들면 다음과 같습니다.

[root@master-zone]# radosgw-admin key create --subuser=johndoe:swift --key-type=swift --gen-secret

{ "user_id": "johndoe",

"rados_uid": 0,

"display_name": "John Doe",

"email": "john@example.com",

"suspended": 0,

"subusers": [

{ "id": "johndoe:swift",

"permissions": "full-control"}],

"keys": [

{ "user": "johndoe",

"access_key": "QFAMEDSJP5DEKJO0DDXY",

"secret_key": "iaSFLDVvDdQt6lkNzHyW4fPLZugBAI1g17LO0+87"}],

"swift_keys": [

{ "user": "johndoe:swift",

"secret_key": "E9T2rUZNu2gxUjcwUBO8n\/Ev4KX6\/GprEuH4qhu1"}]}3.6.11. 액세스 키 추가 및 제거

사용자 및 하위 사용자는 S3 및 Swift 인터페이스를 사용하려면 액세스 키가 있어야 합니다. 사용자 또는 하위 사용자를 생성하고 액세스 키와 시크릿을 지정하지 않으면 키와 시크릿이 자동으로 생성됩니다. 키를 생성하고 액세스 키 및/또는 시크릿을 지정하거나 생성할 수 있습니다. 액세스 키와 시크릿을 제거할 수도 있습니다. 옵션은 다음과 같습니다.

-

--secret=<key>는 비밀 키를 지정합니다(예: 수동으로 생성). -

--Gen-access-key는 임의 액세스 키를 생성합니다(기본적으로 S3 사용자의 경우). -

--Gen-secret은 임의 비밀 키를 생성합니다. -

--key-type=<type>은 키 유형을 지정합니다. 옵션은 swift, s3입니다.

키를 추가하려면 사용자를 지정합니다.

[root@master-zone]# radosgw-admin key create --uid=johndoe --key-type=s3 --gen-access-key --gen-secret

키와 시크릿을 지정할 수도 있습니다.

액세스 키를 제거하려면 사용자와 키를 지정해야 합니다.

특정 사용자에 대한 액세스 키를 찾습니다.

[root@master-zone]# radosgw-admin user info --uid=<testid>

액세스 키는 출력의

"access_key"값입니다. 예를 들면 다음과 같습니다.$ radosgw-admin user info --uid=johndoe { "user_id": "johndoe", ... "keys": [ { "user": "johndoe", "access_key": "0555b35654ad1656d804", "secret_key": "h7GhxuBLTrlhVUyxSPUKUV8r/2EI4ngqJxD7iBdBYLhwluN30JaT3Q==" } ], ... }액세스 키를 제거하려면 사용자 ID와 이전 단계의 액세스 키를 지정합니다.

[root@master-zone]# radosgw-admin key rm --uid=<user_id> --access-key <access_key>

예를 들면 다음과 같습니다.

[root@master-zone]# radosgw-admin key rm --uid=johndoe --access-key 0555b35654ad1656d804

3.6.12. 관리 기능 추가 및 제거

Ceph Storage 클러스터는 사용자가 REST API를 통해 관리 기능을 실행할 수 있는 관리 API를 제공합니다. 기본적으로 사용자는 이 API에 액세스할 수 없습니다. 사용자가 관리 기능을 수행할 수 있도록 하려면 사용자에게 관리 기능을 제공합니다.

사용자에게 관리 기능을 추가하려면 다음을 실행합니다.

[root@master-zone]# radosgw-admin caps add --uid={uid} --caps={caps}사용자, 버킷, 메타데이터 및 사용(utilization)에 읽기, 쓰기 또는 모든 기능을 추가할 수 있습니다. 예를 들면 다음과 같습니다.

--caps="[users|buckets|metadata|usage|zone]=[*|read|write|read, write]"

예를 들면 다음과 같습니다.

[root@master-zone]# radosgw-admin caps add --uid=johndoe --caps="users=*"

사용자의 관리 기능을 제거하려면 다음을 실행합니다.

[root@master-zone]# radosgw-admin caps remove --uid=johndoe --caps={caps}3.7. 할당량 관리

Ceph 개체 게이트웨이를 사용하면 사용자가 소유한 사용자와 버킷에 할당량을 설정할 수 있습니다. 쿼터에는 버킷의 최대 오브젝트 수와 최대 스토리지 크기(MB)가 포함됩니다.

-

버킷: bucket

옵션을사용하면 사용자가 소유한 버킷의 할당량을 지정할 수 있습니다. -

최대 객체: max

-objects설정을 사용하면 최대 오브젝트 수를 지정할 수 있습니다. 음수 값은 이 설정을 비활성화합니다. -

최대 크기: max

-size옵션을 사용하면 최대 바이트 수에 대한 할당량을 지정할 수 있습니다. 음수 값은 이 설정을 비활성화합니다. -

할당량 범위:

quota-scope옵션은 할당량의 범위를 설정합니다. 옵션은버킷과사용자입니다. 버킷 할당량은 사용자가 소유한 버킷에 적용됩니다. 사용자 할당량은 사용자에게 적용됩니다.

오브젝트 수가 많은 버킷으로 인해 심각한 성능 문제가 발생할 수 있습니다. 하나의 버킷에서 권장되는 최대 오브젝트 수는 100,000개입니다. 이 수를 늘리려면 버킷 인덱스 분할을 구성합니다. 자세한 내용은 3.4절. “버킷 분할 구성” 을 참조하십시오.

3.7.1. 사용자 할당량 설정

할당량을 활성화하기 전에 먼저 할당량 매개 변수를 설정해야 합니다. 예를 들면 다음과 같습니다.

[root@master-zone]# radosgw-admin quota set --quota-scope=user --uid=<uid> [--max-objects=<num objects>] [--max-size=<max size>]

예를 들면 다음과 같습니다.

radosgw-admin quota set --quota-scope=user --uid=johndoe --max-objects=1024 --max-size=1024

num 오브젝트 및 / 또는 max 크기의 음수 값은 특정 할당량 특성 확인이 비활성화되었음을 나타냅니다.

3.7.2. 사용자 할당량 활성화 및 비활성화

사용자 할당량을 설정하고 나면 활성화할 수 있습니다. 예를 들면 다음과 같습니다.

[root@master-zone]# radosgw-admin quota enable --quota-scope=user --uid=<uid>

활성화된 사용자 할당량을 비활성화할 수 있습니다. 예를 들면 다음과 같습니다.

[root@master-zone]# radosgw-admin quota disable --quota-scope=user --uid=<uid>

3.7.3. 버킷 할당량 설정

버킷 할당량은 지정된 uid 가 소유한 버킷에 적용됩니다. 해당 사용자는 사용자와 독립적입니다.

구문

radosgw-admin quota set --uid=USER_ID --quota-scope=bucket --bucket=BUCKET_NAME [--max-objects=NUMBER_OF_OBJECTS] [--max-size=MAXIMUM_SIZE_IN_BYTES]

NUMBER_OF_OBJECTS,MAXIMUM_SIZE_IN_BYTES 의 음수 값 또는 두 가지 모두 특정 할당량 특성 확인이 비활성화되어 있음을 나타냅니다.

3.7.4. 버킷 할당량 활성화 및 비활성화

버킷 할당량을 설정하고 나면 활성화할 수 있습니다. 예를 들면 다음과 같습니다.

[root@master-zone]# radosgw-admin quota enable --quota-scope=bucket --uid=<uid>

활성화된 버킷 할당량을 비활성화할 수 있습니다. 예를 들면 다음과 같습니다.

[root@master-zone]# radosgw-admin quota disable --quota-scope=bucket --uid=<uid>

3.7.5. 할당량 설정 가져오기

사용자 정보 API를 통해 각 사용자의 할당량 설정에 액세스할 수 있습니다. CLI 인터페이스를 사용하여 사용자 할당량 설정 정보를 읽으려면 다음을 실행합니다.

# radosgw-admin user info --uid=<uid>

테넌트된 사용자의 할당량 설정을 가져오려면 사용자 ID와 테넌트 이름을 지정합니다.