설치 가이드

Red Hat Enterprise Linux에 Red Hat Ceph Storage 설치

초록

1장. Red Hat Ceph Storage란 무엇입니까?

Red Hat Ceph Storage는 엔터프라이즈급 버전의 Ceph 스토리지 시스템을 Ceph 관리 플랫폼, 배포 유틸리티 및 지원 서비스와 결합하는 확장 가능한 오픈 소프트웨어 정의 스토리지 플랫폼입니다. Red Hat Ceph Storage는 클라우드 인프라 및 웹 규모 개체 스토리지를 위해 설계되었습니다. Red Hat Ceph Storage 클러스터는 다음과 같은 유형의 노드로 구성됩니다.

Red Hat Ceph Storage Ansible 관리

Ansible 관리 노드는 이전 버전의 Red Hat Ceph Storage에서 사용된 기존 Ceph 관리 노드를 대체합니다. Ansible 관리 노드는 다음 기능을 제공합니다.

- 중앙 집중식 스토리지 클러스터 관리.

- Ceph 구성 파일 및 키.

- 보안상의 이유로 인터넷에 액세스할 수 없는 노드에 Ceph를 설치하기 위한 로컬 리포지토리가 필요한 경우도 있습니다.

Ceph Monitor

각 Ceph Monitor 노드는 스토리지 클러스터 맵의 마스터 복사본을 유지 관리하는 ceph-mon 데몬을 실행합니다. 스토리지 클러스터 맵에는 스토리지 클러스터 토폴로지가 포함됩니다. Ceph 스토리지 클러스터에 연결된 클라이언트는 Ceph Monitor에서 스토리지 클러스터 맵의 현재 복사본을 검색하여 클라이언트가 스토리지 클러스터에 데이터를 읽고 쓸 수 있습니다.

스토리지 클러스터는 하나의 Ceph 모니터에서만 실행할 수 있지만 프로덕션 환경의 스토리지 클러스터에서 고가용성을 보장하기 위해 Red Hat은 적어도 3개의 Ceph Monitor 노드를 사용하는 배포만 지원합니다. Red Hat은 750 Ceph OSD 이상의 스토리지 클러스터에 대해 총 5개의 Ceph Monitor를 배포할 것을 권장합니다.

Ceph OSD

각 Ceph OSD(Ceph Object Storage Device) 노드는 ceph-osd 데몬을 실행하고 노드에 연결된 논리 디스크와 상호 작용합니다. 스토리지 클러스터는 데이터를 이러한 Ceph OSD 노드에 저장합니다.

Ceph는 매우 적은 수의 OSD 노드에서 실행할 수 있습니다. 기본값은 3개이지만, 프로덕션 스토리지 클러스터는 크기가 조정될 때 더 나은 성능을 구현할 수 있습니다. 예를 들어 스토리지 클러스터에 있는 50개의 Ceph OSD가 있습니다. Ceph 스토리지 클러스터에는 여러 개의 OSD 노드가 있으므로 CRUSH 매핑을 적절하게 구성하여 장애 도메인을 격리할 수 있습니다.

Ceph MDS

각 Ceph 메타데이터 서버(MDS) 노드는 Ceph 파일 시스템(CephFS)에 저장된 파일과 관련된 메타데이터를 관리하는 ceph-mds 데몬을 실행합니다. Ceph MDS 데몬은 공유 스토리지 클러스터에 대한 액세스도 조정합니다.

Ceph Object Gateway

Ceph Object Gateway 노드는 ceph-radosgw 데몬을 실행하며, Ceph 스토리지 클러스터에 대한 RESTful 액세스 지점을 애플리케이션에 제공하기 위해 librados 상단에 빌드된 오브젝트 스토리지 인터페이스입니다. Ceph Object Gateway는 다음 두 개의 인터페이스를 지원합니다.

S3

Amazon S3 RESTful API의 큰 하위 집합과 호환되는 인터페이스가 포함된 오브젝트 스토리지 기능을 제공합니다.

Swift

OpenStack Swift API의 대규모 하위 집합과 호환되는 인터페이스가 포함된 오브젝트 스토리지 기능을 제공합니다.

추가 리소스

- Ceph 아키텍처에 대한 자세한 내용은 Red Hat Ceph Storage Architecture Guide를 참조하십시오.

- 최소 하드웨어 권장 사항은 Red Hat Ceph Storage 하드웨어 선택 가이드를 참조하십시오.

2장. Red Hat Ceph Storage 고려 사항 및 권장 사항

스토리지 관리자는 Red Hat Ceph Storage 클러스터를 실행하기 전에 고려해야 할 사항을 기본적으로 이해해야 합니다. 하드웨어 및 네트워크 요구 사항, Red Hat Ceph Storage 클러스터와 호환되는 워크로드 유형의 이해 및 Red Hat의 권장 사항을 검토하십시오. Red Hat Ceph Storage는 특정 비즈니스 요구 사항 또는 일련의 요구 사항에 따라 다양한 워크로드에 사용할 수 있습니다. Red Hat Ceph Storage를 설치하기 전에 필요한 계획을 수행하는 것은 Ceph 스토리지 클러스터를 효율적으로 실행하는 데 있어 비즈니스 요구 사항을 달성하는 데 매우 중요합니다.

특정 사용 사례에 맞게 Red Hat Ceph Storage 클러스터를 계획하는 데 도움이 필요하십니까? 자세한 내용은 Red Hat 담당자에게 문의하십시오.

2.1. 사전 요구 사항

- 스토리지 솔루션을 이해, 검토 및 계획할 시간을 확보합니다.

2.2. Red Hat Ceph Storage의 기본 고려 사항

Red Hat Ceph Storage를 사용하는 첫 번째 고려 사항은 데이터를 위한 스토리지 전략을 개발하는 것입니다. 스토리지 전략은 특정 사용 사례에 서비스를 제공하는 데이터를 저장하는 방법입니다. OpenStack과 같은 클라우드 플랫폼에 대한 볼륨과 이미지를 저장해야 하는 경우 저널용 SSD(Solid State Drives)로 더 빠른 SAS( Serial Attached SCSI) 드라이브에 데이터를 저장하도록 선택할 수 있습니다. 반대로 S3 또는 Swift 호환 게이트웨이에 대한 오브젝트 데이터를 저장해야 하는 경우 기존 SATA(Serial Advanced Technology Attachment) 드라이브와 같이 더 경제적인 것을 사용할 수 있습니다. Red Hat Ceph Storage는 동일한 스토리지 클러스터에 있는 두 시나리오를 모두 수용할 수 있지만, 클라우드 플랫폼에 빠른 스토리지 전략을 제공하는 수단과 개체 저장소에 더 많은 기존 스토리지를 제공하는 수단이 필요합니다.

Ceph 배포의 가장 중요한 단계 중 하나는 스토리지 클러스터의 사용 사례와 워크로드에 적합한 가격대 성능 프로필을 식별하는 것입니다. 사용 사례에 적합한 하드웨어를 선택하는 것이 중요합니다. 예를 들어, 콜드 스토리지 애플리케이션에 최적화된 IOPS 하드웨어를 선택하면 하드웨어 비용이 불필요하게 증가합니다. 반면, IOPS 집약적인 워크로드에서 용량에 최적화된 하드웨어를 선택하는 경우 성능 저하에 대해 불만을 제기하는 사용자가 불만을 줄 수 있습니다.

Red Hat Ceph Storage는 여러 스토리지 전략을 지원할 수 있습니다. 사운드 스토리지 전략을 개발하는 데 도움이 되는 사용 사례, 비용 대비 성능 장단점 및 데이터 지속성이 가장 중요한 고려 사항입니다.

사용 사례

Ceph는 대용량 스토리지 용량을 제공하며 다음과 같은 다양한 사용 사례를 지원합니다.

- Ceph 블록 장치 클라이언트는 COW(Copy-On-Write 복제)와 같은 고성능 기능을 갖춘 볼륨 및 이미지에 대한 무제한 스토리지를 제공하는 클라우드 플랫폼용 최고의 스토리지 백엔드입니다.

- Ceph Object Gateway 클라이언트는 오디오, 비트맵, 비디오 및 기타 데이터와 같은 오브젝트에 RESTful S3 호환 및 Swift 호환 개체 스토리지를 제공하는 클라우드 플랫폼용 최고의 스토리지 백엔드입니다.

- 기존 파일 스토리지를 위한 Ceph 파일 시스템입니다.

비용 vs. 성능 이점

속도, 크기, 내구성 등이 더 우수합니다. 그러나 각 최상급 품질에는 각각 비용이 들기 때문에 비용 효율적인 측면에서 그에 상응하는 비용 대 편익 절충이 있습니다. 성능 관점에서 다음 사용 사례를 고려하십시오. SSD는 상대적으로 적은 양의 데이터와 저널링에 매우 빠른 스토리지를 제공할 수 있습니다. 데이터베이스 또는 개체 인덱스를 저장하면 매우 빠른 SSD 풀의 이점을 얻을 수 있지만 다른 데이터에 너무 많은 비용이 듭니다. SSD 저널링을 사용하는 SAS 드라이브는 볼륨과 이미지의 경제적인 가격으로 빠른 성능을 제공합니다. SSD 저널링이 없는 SATA 드라이브는 전체 성능이 낮은 저렴한 스토리지를 제공합니다. OSD의 CRUSH 계층 구조를 생성할 때 사용 사례 및 허용 가능한 비용 대신 성능 트레이드를 고려해야 합니다.

데이터 내결함성

대규모 클러스터에서는 하드웨어 장애가 예상되며 예외는 아닙니다. 그러나 데이터 손실 및 서비스 중단은 허용되지 않습니다. 이러한 이유로 데이터 지속성이 매우 중요합니다. Ceph는 여러 오브젝트 복제본 사본 또는 삭제 코딩 및 여러 코딩 청크를 사용하여 데이터 지속성을 처리합니다. 여러 복사본 또는 여러 코딩 청크를 사용하면 추가 비용과 혜택의 장단점이 있습니다. 즉, 복사본 또는 코딩 청크를 더 적게 저장하는 것이 더 저렴하지만 성능 저하된 상태로 서비스 쓰기 요청을 사용할 수 없게 될 수 있습니다. 일반적으로 두 개의 추가 사본이 있는 하나의 오브젝트 또는 두 개의 코딩 청크를 사용하면 스토리지 클러스터를 복구하는 동안 성능이 저하된 상태로 스토리지 클러스터가 기록되도록 할 수 있습니다.

복제는 하드웨어 장애 발생 시 장애 도메인에서 데이터의 중복 복사본을 하나 이상 저장합니다. 그러나 데이터의 중복 복사본은 규모에 따라 비용이 많이 들 수 있습니다. 예를 들어, 3개 복제를 사용하여 1페타바이트의 데이터를 저장하려면 최소 3페타바이트 이상의 스토리지 용량이 있는 클러스터가 필요합니다.

코딩 삭제는 데이터를 데이터 청크 및 코딩 청크로 저장합니다. 데이터 청크가 손실되는 경우 삭제 코딩은 나머지 데이터 청크 및 코딩 청크를 사용하여 손실된 데이터 청크를 복구할 수 있습니다. 삭제 코딩은 복제보다 상당히 경제적입니다. 예를 들어 데이터 청크 8개와 코딩 청크 3개가 있는 삭제 코딩을 사용하면 데이터 복사본 3개와 동일한 중복성이 제공됩니다. 그러나 이러한 인코딩 체계는 복제와 3x에 비해 저장된 초기 데이터의 약 1.5x를 사용합니다.

CRUSH 알고리즘은 Ceph가 스토리지 클러스터 내의 다른 위치에 추가 사본 또는 코딩 청크를 저장할 수 있도록 하여 이 프로세스를 지원합니다. 이렇게 하면 단일 스토리지 장치 또는 노드에 장애가 발생해도 데이터 손실을 방지하는 데 필요한 모든 복사 또는 코딩 청크가 손실되지 않습니다. 비용 대비 이점의 장단점이 있는 스토리지 전략을 계획하고 데이터 지속성을 염두에 두고 Ceph 클라이언트에 스토리지 풀로 제공할 수 있습니다.

데이터 스토리지 풀만 삭제 코딩을 사용할 수 있습니다. 서비스 데이터 및 버킷 인덱스를 저장하는 풀은 복제를 사용합니다.

Ceph의 개체 복사 또는 코딩 청크를 사용하면 RAID 솔루션이 더 이상 사용되지 않습니다. Ceph는 이미 데이터 지속성을 처리하므로 RAID를 사용하지 마십시오. 성능이 저하된 RAID는 성능에 부정적인 영향을 미치며 RAID를 사용하여 데이터를 복구하는 것은 깊은 복사본 또는 코딩 청크를 사용하는 것보다 훨씬 느립니다.

추가 리소스

- 자세한 내용은 Red Hat Ceph Storage 설치 가이드의 Red Hat Ceph Storage의 최소 하드웨어 고려 사항 섹션을 참조하십시오.

2.3. Red Hat Ceph Storage 워크로드 고려 사항

Ceph 스토리지 클러스터의 주요 이점 중 하나는 성능 도메인을 사용하여 동일한 스토리지 클러스터 내에서 다양한 유형의 워크로드를 지원할 수 있다는 것입니다. 각 성능 도메인과 다른 하드웨어 구성을 연결할 수 있습니다. 스토리지 관리자는 적절한 성능 도메인에 스토리지 풀을 배포할 수 있으므로 애플리케이션에 특정 성능 및 비용 프로필에 맞는 스토리지를 제공할 수 있습니다. 이러한 성능 도메인에 맞게 크기가 조정되고 최적화된 서버를 선택하는 것은 Red Hat Ceph Storage 클러스터를 설계하는 데 있어 필수적인 부분입니다.

데이터를 읽고 쓰는 Ceph 클라이언트 인터페이스의 경우 Ceph 스토리지 클러스터는 클라이언트가 데이터를 저장하는 간단한 풀로 나타납니다. 그러나 스토리지 클러스터는 클라이언트 인터페이스에 완전히 투명한 방식으로 많은 복잡한 작업을 수행합니다. Ceph OSD라고 하는 Ceph 클라이언트 및 Ceph 개체 스토리지 데몬은 모두 오브젝트 스토리지 및 검색에 대해 CRUSH(Controlled Replication Under Scalable Hashing) 알고리즘을 사용합니다. Ceph OSD는 컨테이너 또는 RPM 기반 배포를 사용하여 스토리지 클러스터 내의 베어 메탈 서버 또는 가상 시스템에서 실행할 수 있습니다.

CRUSH 맵은 클러스터 리소스의 토폴로지를 설명하고 이 맵은 클라이언트 노드와 클러스터 내의 Ceph 모니터 노드에 모두 존재합니다. Ceph 클라이언트 및 Ceph OSD는 모두 CRUSH 맵과 CRUSH 알고리즘을 사용합니다. Ceph 클라이언트는 OSD와 직접 통신하여 중앙 집중식 개체 조회 및 잠재적인 성능 병목 현상을 제거합니다. CRUSH 맵과 해당 피어의 통신을 인식하면 OSD에서 복제, 백필 및 복구 기능을 처리할 수 있으므로 동적 오류 복구를 수행할 수 있습니다.

Ceph는 CRUSH 맵을 사용하여 장애 도메인을 구현합니다. 또한 Ceph는 CRUSH 맵을 사용하여 성능 도메인을 구현합니다. 이 도메인은 단순히 기본 하드웨어의 성능 프로파일을 고려합니다. CRUSH 맵은 Ceph가 데이터를 저장하는 방법을 설명하고, 이는 단순한 계층 구조, 특히 재활용 그래프 및 규칙 세트로 구현됩니다. CRUSH 맵은 여러 계층 구조를 지원하여 한 가지 유형의 하드웨어 성능 프로필을 분리할 수 있습니다. Ceph는 장치 "클래스"로 성능 도메인을 구현합니다.

예를 들어 동일한 Red Hat Ceph Storage 클러스터에 이러한 성능 도메인을 공존할 수 있습니다.

- 일반적으로 HDD(하드 디스크 드라이브)는 비용 및 용량 중심 워크로드에 적합합니다.

- 처리량에 민감한 워크로드는 일반적으로 SSD(반도체 드라이브)에서 Ceph 쓰기 저널과 함께 HDD를 사용합니다.

- MySQL 및 MariaDB와 같은 IOPS 집약적인 워크로드에서는 SSD를 사용하는 경우가 많습니다.

워크로드

Red Hat Ceph Storage는 세 가지 주요 워크로드에 최적화되어 있습니다:

IOPS 최적화: IOPS(초당 입력, 출력당) 최적화 배포는 OpenStack에서 가상 시스템으로 RuntimeClass 또는 MariaDB 인스턴스를 실행하는 것과 같은 클라우드 컴퓨팅 작업에 적합합니다. IOPS 최적화된 배포에는 15k RPM SAS 드라이브와 같은 고성능 스토리지 및 자주 쓰기 작업을 처리하기 위해 별도의 SSD 저널이 필요합니다. 일부 IOPS 시나리오에서는 모든 Flash 스토리지를 사용하여 IOPS 및 총 처리량을 개선합니다.

IOPS가 최적화된 스토리지 클러스터에는 다음과 같은 속성이 있습니다.

- IOPS당 최소 비용.

- GB당 최대 IOPS.

- 99번째 백분위 대기 시간 일관성.

IOPS에 최적화된 스토리지 클러스터의 용도는 다음과 같습니다.

- 일반적인 블록 스토리지.

- 하드 드라이브(HDD)의 3x 복제 또는 솔리드 스테이트 드라이브(SSD)의 2x 복제.

- OpenStack 클라우드의 MySQL.

최적화된 처리량: 처리량 최적화 배포는 그래픽, 오디오 및 비디오 콘텐츠와 같은 상당한 양의 데이터를 제공하는 데 적합합니다. 처리량에 최적화된 배포에는 높은 대역폭 네트워킹 하드웨어, 컨트롤러 및 하드 디스크 드라이브, 순차적 읽기 및 쓰기 기능이 필요합니다. 빠른 데이터 액세스가 요구 사항인 경우 처리량 최적화 스토리지 전략을 사용합니다. 또한 빠른 쓰기 성능이 필요한 경우 저널에 Solid State Disks (SSD)를 사용하면 쓰기 성능이 크게 향상됩니다.

처리량 최적화 스토리지 클러스터에는 다음과 같은 속성이 있습니다.

- MBps당 가장 낮은 비용(처리량)

- TB당 최대 MBps

- BTU당 최대 MBps

- Watt당 가장 높은 MBps

- 97%의 대기 시간 일관성

처리량 최적화 스토리지 클러스터에 대한 사용은 다음과 같습니다.

- 블록 또는 오브젝트 스토리지

- 3x 복제

- 비디오, 오디오 및 이미지를 위한 활성 성능 스토리지

- 4K 영상 등의 스트리밍 미디어

용량 최적화: 용량 최적화 배포는 많은 양의 데이터를 최대한 저렴하게 저장하는 데 적합합니다. 용량 최적화 배포는 일반적으로 더 큰 가격대에 대한 성능을 거래합니다. 예를 들어 용량 최적화 배포에서는 저널링에 SSD를 사용하지 않고 속도가 느리고 비용이 적게 드는 SATA 드라이브를 사용하는 경우가 많습니다.

비용 및 용량 최적화 스토리지 클러스터에는 다음과 같은 속성이 있습니다.

- TB당 최소 비용

- TB당 최소 BTU 수

- TB당 필요한 최소 Watt

비용 및 용량 최적화 스토리지 클러스터에 대한 사용은 다음과 같습니다.

- 일반적으로 오브젝트 스토리지

- 사용 가능한 용량을 극대화하기 위한 지우기 코딩

- 오브젝트 아카이브

- 비디오, 오디오 및 이미지 오브젝트 리포지토리

스토리지 클러스터의 가격 및 성능에 큰 영향을 미칠 수 있으므로 어떤 하드웨어를 구입할지 고려하기 전에 Red Hat Ceph Storage 클러스터에서 실행되는 워크로드를 신중하게 고려합니다. 예를 들어 워크로드가 용량에 최적화되고 처리량이 최적화된 워크로드에 하드웨어가 더 적합한 경우 하드웨어는 필요한 것보다 비용이 많이 듭니다. 반대로 워크로드가 처리량에 최적화되고 하드웨어가 용량이 최적화된 워크로드에 더 적합한 경우 스토리지 클러스터가 성능이 저하될 수 있습니다.

2.4. Red Hat Ceph Storage의 네트워크 고려 사항

클라우드 스토리지 솔루션의 중요한 측면은 네트워크 대기 시간 및 기타 요인으로 인해 스토리지 클러스터가 IOPS에서 실행될 수 있다는 것입니다. 또한 스토리지 클러스터에 스토리지 용량이 부족하기 전에 대역폭 제약으로 인해 처리량이 부족할 수 있습니다. 즉, 가격 대비 성능 요구 사항을 충족하기 위해 네트워크 하드웨어 구성에서 선택한 워크로드를 지원해야 합니다.

스토리지 관리자는 스토리지 클러스터를 최대한 빨리 복구하는 것을 선호합니다. 저장소 클러스터 네트워크에 대한 대역폭 요구 사항을 신중하게 고려하고 네트워크 링크 초과 서브스크립션에 유의하고 클러스터 내 트래픽을 클라이언트 간 트래픽에서 분리합니다. 또한 SSD(Solid State Disk), 플래시, NVMe 및 기타 고성능 저장 장치의 사용을 고려할 때 네트워크 성능이 점점 더 중요해진다는 점을 고려하십시오.

Ceph는 공용 네트워크 및 스토리지 클러스터 네트워크를 지원합니다. 공용 네트워크는 Ceph 모니터와의 통신 및 클라이언트 트래픽을 처리합니다. 스토리지 클러스터 네트워크는 Ceph OSD 하트비트, 복제, 백필링 및 복구 트래픽을 처리합니다. 최소한 하나의 10GB 이더넷 링크를 스토리지 하드웨어에 사용해야 하며 연결 및 처리량을 위해 10GB 이더넷 링크를 추가할 수 있습니다.

Red Hat은 스토리지 클러스터 네트워크에 대역폭을 할당하는 것이 좋습니다. 따라서 복제된 풀에서 여러 풀에 대한 기준으로 osd_pool_default_size를 사용하는 공용 네트워크의 배수입니다. 또한 별도의 네트워크 카드에서 공용 및 스토리지 클러스터 네트워크를 실행하는 것이 좋습니다.

Red Hat은 프로덕션 환경에서 Red Hat Ceph Storage 배포에 10GB 이더넷을 사용할 것을 권장합니다. 1GB 이더넷 네트워크는 프로덕션 스토리지 클러스터에 적합하지 않습니다.

드라이브 오류가 발생하는 경우 1GB 이더넷 네트워크에서 1TB의 데이터를 복제하는 데 3시간이 걸리며 3TB의 데이터를 9시간이 소요됩니다. 3TB를 사용하는 것이 일반적인 드라이브 구성입니다. 반대로 10GB 이더넷 네트워크를 사용하면 각각 20분과 1시간이 걸립니다. Ceph OSD가 실패하면 풀 내의 다른 Ceph OSD에 포함된 데이터를 복제하여 스토리지 클러스터를 복구합니다.

랙과 같은 더 큰 도메인에 장애가 발생하면 스토리지 클러스터가 훨씬 더 많은 대역폭을 활용하게 됩니다. 대규모 스토리지 구현에 공통적인 여러 랙으로 구성된 스토리지 클러스터를 구축할 때 최적의 성능을 위해 "팻 트리" 설계의 스위치 간 네트워크 대역폭을 최대한 활용하는 것이 좋습니다. 일반적인 10GB 이더넷 스위치에는 48개의 10GB 포트와 40GB 포트 4개가 있습니다. 최대 처리량을 위해 스파인에서 40GB 포트를 사용합니다. 또는 다른 랙 및 스파인 라우터에 연결하기 위해 사용하지 않는 10GB 포트를 40GB 이상의 포트로 집계하는 것이 좋습니다. 또한 네트워크 인터페이스를 결합하는 데 LACP 모드 4를 사용하는 것이 좋습니다. 또한 점보 프레임, MTU(최대 전송 단위) 9000, 특히 백엔드 또는 클러스터 네트워크에서 사용합니다.

Red Hat Ceph Storage 클러스터를 설치하고 테스트하기 전에 네트워크 처리량을 확인합니다. Ceph에서 대부분의 성능 관련 문제는 일반적으로 네트워킹 문제로 시작합니다. kinked 또는 bent cat-6 케이블과 같은 간단한 네트워크 문제로 인해 대역폭이 저하될 수 있습니다. 전면 네트워크에 최소 10GB 이더넷을 사용합니다. 대규모 클러스터의 경우 백엔드 또는 클러스터 네트워크에 40GB 이더넷을 사용하는 것이 좋습니다.

네트워크 최적화를 위해 Red Hat은 대역폭당 CPU를 개선하고 차단되지 않는 네트워크 스위치 백 플레인에 점보 프레임을 사용하는 것이 좋습니다. Red Hat Ceph Storage는 공용 네트워크와 클러스터 네트워크 모두에 대해 통신 경로의 모든 네트워킹 장치에 걸쳐 동일한 MTU 값이 필요합니다. 프로덕션에서 Red Hat Ceph Storage 클러스터를 사용하기 전에 MTU 값이 환경의 모든 노드 및 네트워킹 장비에서 같은지 확인합니다.

추가 리소스

- 자세한 내용은 Red Hat Ceph Storage 구성 가이드 의 MTU 값 확인 및 구성을 참조하십시오.

2.5. Ceph를 실행할 때 Linux 커널 튜닝 고려 사항

프로덕션 Red Hat Ceph Storage 클러스터는 일반적으로 운영 체제 조정, 특히 제한 및 메모리 할당의 이점을 제공합니다. 스토리지 클러스터 내의 모든 노드에 대해 조정이 설정되어 있는지 확인합니다. 추가 지침을 요구하는 Red Hat 지원 케이스를 열 수도 있습니다.

Ceph OSD의 여유 메모리 예약

Ceph OSD 메모리 할당 요청 중에 메모리 관련 오류가 충분하지 않도록 하려면 예약된 물리적 메모리 양을 설정합니다. Red Hat은 시스템 RAM 용량에 따라 다음 설정을 권장합니다.

64GB의 경우 1GB를 예약합니다.

vm.min_free_kbytes = 1048576

128GB의 경우 2GB를 예약합니다.

vm.min_free_kbytes = 2097152

256GB의 경우 3GB를 예약합니다.

vm.min_free_kbytes = 3145728

파일 디스크립터 증가

Ceph Object Gateway는 파일 디스크립터가 부족하면 중지될 수 있습니다. Ceph Object Gateway 노드에서 /etc/security/limits.conf 파일을 수정하여 Ceph Object Gateway의 파일 설명자를 늘릴 수 있습니다.

ceph soft nofile unlimited

대규모 스토리지 클러스터의 ulimit 값 조정

대규모 스토리지 클러스터에서 Ceph 관리 명령을 실행하는 경우 예를 들어 1024개의 Ceph OSD가 있는 경우 다음 콘텐츠로 관리 명령을 실행하는 각 노드에 /etc/security/limits.d/50-ceph.conf 파일을 생성합니다.

USER_NAME soft nproc unlimitedUSER_NAME을 Ceph 관리 명령을 실행하는 루트가 아닌 사용자 계정의 이름으로 바꿉니다.

루트 사용자의 ulimit 값은 Red Hat Enterprise Linux에서 기본적으로 ulimit으로 이미 설정되어 있습니다.

2.6. OSD 노드에서 RAID 컨트롤러 사용 고려 사항

선택적으로 OSD 노드에서 RAID 컨트롤러를 사용하는 것을 고려할 수 있습니다. 다음은 고려해야 할 몇 가지 사항입니다.

- OSD 노드에 1-2GB의 캐시가 설치된 RAID 컨트롤러가 있는 경우 나중 쓰기 캐시를 활성화하면 I/O 쓰기 처리량이 줄어들 수 있습니다. 그러나 캐시는 비휘발성이어야 합니다.

- 대부분의 최신 RAID 컨트롤러에는 전원 손실 이벤트 중에 휘발성 메모리를 비휘발성 NAND 메모리에 드레이닝할 수 있는 충분한 성능을 제공하는 슈퍼 커패시터가 있습니다. 전원이 복원된 후 특정 컨트롤러와 펌웨어가 작동하는 방식을 이해하는 것이 중요합니다.

- 일부 RAID 컨트롤러에는 수동 조작이 필요합니다. 하드 드라이브는 일반적으로 디스크 캐시를 사용하도록 설정해야 하는지 여부를 운영 체제에 알립니다. 그러나 특정 RAID 컨트롤러와 일부 펌웨어는 이러한 정보를 제공하지 않습니다. 파일 시스템 손상을 방지하기 위해 디스크 수준 캐시가 비활성화되어 있는지 확인합니다.

- 나중 쓰기 캐시가 활성화된 각 Ceph OSD 데이터 드라이브에 다시 쓰기를 설정하여 단일 RAID 0 볼륨을 생성합니다.

- 직렬 연결 SCSI (SAS) 또는 SATA 연결 Solid-state Drive (SSD) 디스크가 RAID 컨트롤러에도 존재하는 경우 컨트롤러 및 펌웨어가 pass-through 모드를 지원하는지 확인합니다. pass-through 모드를 활성화하면 캐싱 논리를 방지할 수 있으며 일반적으로 빠른 미디어에서 대기 시간이 훨씬 짧아집니다.

2.7. Object Gateway에서 NVMe 사용 고려 사항

선택적으로 Ceph Object Gateway에 NVMe를 사용할 수 있습니다.

Red Hat Ceph Storage의 오브젝트 게이트웨이 기능을 사용하고 OSD 노드에서 NVMe 기반 SSD를 사용하는 경우 프로덕션 가이드의 Ceph Object Gateway 를 최적으로 사용하여 NVMe 사용 섹션에서 다음 절차를 고려하십시오. 이 절차에서는 SSD에 저널 및 버킷 인덱스를 함께 배치하는 특수 설계된 Ansible 플레이북을 사용하는 방법을 설명하므로 한 장치에 모든 저널을 사용하는 것보다 성능을 향상시킬 수 있습니다.

2.8. Red Hat Ceph Storage의 최소 하드웨어 고려 사항

Red Hat Ceph Storage는 비독점 상용 하드웨어에서 실행할 수 있습니다. 소규모 프로덕션 클러스터 및 개발 클러스터는 모드형 하드웨어를 사용하여 성능 최적화 없이 실행될 수 있습니다.

Red Hat Ceph Storage는 베어 메탈 또는 컨테이너화된 배포에 따라 약간 다른 요구 사항이 있습니다.

디스크 공간 요구 사항은 /var/lib/ceph/ 디렉터리에 있는 Ceph 데몬의 기본 경로를 기반으로 합니다.

표 2.1. 베어 메탈

| 프로세스 | 기준 | 최소 권장 사항 |

|---|---|---|

|

| 프로세서 | 1x AMD64 또는 Intel 64 |

| RAM |

| |

| OS 디스크 | 호스트당 1x OS 디스크 | |

| 볼륨 스토리지 | 데몬당 1x 스토리지 드라이브 | |

|

|

선택 사항이지만 Red Hat은 1x SSD 또는 NVMe 또는 Optane 파티션 또는 데몬당 논리 볼륨을 권장합니다. 오브젝트, 파일 및 혼합된 워크로드의 경우 BlueStore용 | |

|

|

데몬당 1x SSD 또는 NVMe 또는 Optane 파티션 또는 논리 볼륨을 선택합니다. 작은 크기(예: 10GB)를 사용하고 | |

| 네트워크 | 2x 10GB 이더넷 NIC | |

|

| 프로세서 | 1x AMD64 또는 Intel 64 |

| RAM | 데몬당 1GB | |

| 디스크 공간 | 데몬당 15GB | |

| 모니터 디스크 |

| |

| 네트워크 | 2x 1GB 이더넷 NIC | |

|

| 프로세서 | 1x AMD64 또는 Intel 64 |

| RAM | 데몬당 1GB | |

| 네트워크 | 2x 1GB 이더넷 NIC | |

|

| 프로세서 | 1x AMD64 또는 Intel 64 |

| RAM | 데몬당 1GB | |

| 디스크 공간 | 데몬당 5GB | |

| 네트워크 | 1x 1GB 이더넷 NIC | |

|

| 프로세서 | 1x AMD64 또는 Intel 64 |

| RAM | 데몬당 2GB

이 수는 구성 가능한 MDS 캐시 크기에 따라 다릅니다. RAM 요구 사항은 일반적으로 | |

| 디스크 공간 | 데몬당 2MB와 로깅에 필요한 공간은 구성된 로그 수준에 따라 다를 수 있습니다. | |

| 네트워크 | 2x 1GB 이더넷 NIC OSD와 동일한 네트워크입니다. OSD에 10GB 네트워크가 있는 경우 대기 시간과 관련하여 MDS의 문제가 발생하지 않도록 MDS에서 동일하게 사용해야 합니다. |

표 2.2. 컨테이너

| 프로세스 | 기준 | 최소 권장 사항 |

|---|---|---|

|

| 프로세서 | OSD 컨테이너당 1x AMD64 또는 Intel 64 CPU CORE |

| RAM | OSD 컨테이너당 최소 5GB의 RAM | |

| OS 디스크 | 호스트당 1x OS 디스크 | |

| OSD 스토리지 | OSD 컨테이너당 1x 스토리지 드라이브. OS 디스크와 공유할 수 없습니다. | |

|

|

선택 사항이지만 Red Hat은 데몬당 1x SSD 또는 NVMe 또는 Optane 파티션 또는 lvm을 권장합니다. 오브젝트, 파일 및 혼합된 워크로드의 경우 BlueStore용 | |

|

|

데몬당 1x SSD 또는 NVMe 또는 Optane 파티션 또는 논리 볼륨 옵션으로 사용할 수 있습니다. 작은 크기(예: 10GB)를 사용하고 | |

| 네트워크 | 2x 10GB 이더넷 NIC, 10GB 권장 | |

|

| 프로세서 | mon-container당 1x AMD64 또는 Intel 64 CPU CORE |

| RAM |

| |

| 디스크 공간 |

| |

| 모니터 디스크 |

선택적으로 | |

| 네트워크 | 2x 1GB 이더넷 NIC, 10GB 권장 | |

|

| 프로세서 |

|

| RAM |

| |

| 네트워크 | 2x 1GB 이더넷 NIC, 10GB 권장 | |

|

| 프로세서 | radosgw-container당 1x AMD64 또는 Intel 64 CPU CORE |

| RAM | 데몬당 1GB | |

| 디스크 공간 | 데몬당 5GB | |

| 네트워크 | 1x 1GB 이더넷 NIC | |

|

| 프로세서 | mds-container당 1x AMD64 또는 Intel 64 CPU CORE |

| RAM |

이 수는 구성 가능한 MDS 캐시 크기에 따라 다릅니다. RAM 요구 사항은 일반적으로 | |

| 디스크 공간 |

2GB의 | |

| 네트워크 | 2x 1GB 이더넷 NIC, 10GB 권장 OSD 컨테이너와 동일한 네트워크입니다. OSD에 10GB 네트워크가 있는 경우 대기 시간과 관련하여 MDS의 문제가 발생하지 않도록 MDS에서 동일하게 사용해야 합니다. |

2.9. 추가 리소스

- Ceph의 다양한 내부 구성 요소와 해당 구성 요소와 관련된 전략을 자세히 살펴보려면 Red Hat Ceph Storage Storage Strategies Guide 를 참조하십시오.

3장. Red Hat Ceph Storage 설치 요구사항

그림 3.1. 사전 요구 사항 워크플로

Red Hat Ceph Storage를 설치하기 전에 다음 요구 사항을 검토하고 그에 따라 각 Monitor, OSD, Metadata Server 및 클라이언트 노드를 준비합니다.

Red Hat Ceph Storage 릴리스 및 해당 Red Hat Ceph Storage 패키지 버전에 대해 알아보려면 Red Hat 고객 포털의 Red Hat Ceph Storage 릴리스 정보 및 해당 Ceph 패키지 버전 문서를 참조하십시오.

3.1. 사전 요구 사항

- 하드웨어가 Red Hat Ceph Storage 4의 최소 요구 사항을 충족하는지 확인합니다.

3.2. Red Hat Ceph Storage 설치를 위한 요구 사항 체크리스트

| Task | 필수 항목 | 섹션 | 권장 사항 |

|---|---|---|---|

| 운영 체제 버전 확인 | 있음 | ||

| Ceph 노드 등록 | 있음 | ||

| Ceph 소프트웨어 리포지토리 활성화 | 있음 | ||

| OSD 노드에서 RAID 컨트롤러 사용 | 없음 | RAID 컨트롤러에서 나중 쓰기 캐시를 활성화하면 OSD 노드의 I/O 쓰기 처리량이 증가할 수 있습니다. | |

| 네트워크 구성 | 있음 | 최소한 퍼블릭 네트워크가 필요합니다. 그러나 클러스터 통신용 프라이빗 네트워크를 사용하는 것이 좋습니다. | |

| 방화벽 구성 | 없음 | 방화벽은 네트워크에 대한 신뢰 수준을 높일 수 있습니다. | |

| Ansible 사용자 생성 | 있음 | 모든 Ceph 노드에 Ansible 사용자를 생성해야 합니다. | |

| 암호 없는 SSH 활성화 | 있음 | Ansible에 필요합니다. |

기본적으로 ceph-ansible은 NTP/chronyd를 요구 사항으로 설치합니다. NTP/chronyd를 사용자 지정하는 경우 수동으로 Red Hat Ceph Storage 설치에서 Network Time Protocol for Red Hat Ceph Storage 섹션을 참조하여 NTP/chronyd가 Ceph에서 제대로 작동하도록 구성해야 합니다.

3.3. Red Hat Ceph Storage의 운영 체제 요구 사항

Red Hat Enterprise Linux 권한은 Red Hat Ceph Storage 서브스크립션에 포함되어 있습니다.

Red Hat Ceph Storage 4의 초기 릴리스는 Red Hat Enterprise Linux 7.7 또는 Red Hat Enterprise Linux 8.1에서 지원됩니다. Red Hat Ceph Storage 4.3의 현재 버전은 Red Hat Enterprise Linux 7.9, 8.2 EUS, 8.4 EUS, 8.5, 8.6, 8.7, 8.8에서 지원됩니다.

Red Hat Ceph Storage 4는 RPM 기반 배포 또는 컨테이너 기반 배포에서 지원됩니다.

Red Hat Enterprise Linux 7에서 실행되는 컨테이너에 Red Hat Ceph Storage 4를 배포하는 경우 Red Hat Enterprise Linux 8 컨테이너 이미지에서 실행되는 Red Hat Ceph Storage 4를 배포합니다.

모든 노드에서 동일한 운영 체제 버전, 아키텍처 및 배포 유형을 사용합니다. 예를 들어, AMD64 및 Intel 64 아키텍처와 함께 노드를 혼합하여 사용하지 마십시오. Red Hat Enterprise Linux 7 및 Red Hat Enterprise Linux 8 운영 체제가 있는 노드가 혼합되거나 RPM 기반 배포 및 컨테이너 기반 배포가 모두 사용되는 노드가 혼합되어 있습니다.

Red Hat은 이기종 아키텍처, 운영 체제 버전 또는 배포 유형이 있는 클러스터를 지원하지 않습니다.

SELinux

기본적으로 SELinux는 Enforcing 모드로 설정되고 ceph-selinux 패키지가 설치됩니다. SELinux에 대한 자세한 내용은 Data Security and Hardening Guide, Red Hat Enterprise Linux 7 SELinux 사용자 및 관리자 가이드 , SELinux 가이드 를 사용하는 Red Hat Enterprise Linux 8을 참조하십시오.

추가 리소스

- Red Hat Enterprise Linux 8용 문서는 https://access.redhat.com/documentation/en-us/red_hat_enterprise_linux/8/에서 확인할 수 있습니다.

- Red Hat Enterprise Linux 7에 대한 문서는 https://access.redhat.com/documentation/en-us/red_hat_enterprise_linux/7/에서 확인할 수 있습니다.

3.4. Red Hat Ceph Storage 노드를 CDN에 등록하고 서브스크립션 연결

각 Red Hat Ceph Storage 노드를 CDN(Content Delivery Network)에 등록하고 노드가 소프트웨어 리포지토리에 액세스할 수 있도록 적절한 서브스크립션을 연결합니다. 각 Red Hat Ceph Storage 노드는 전체 Red Hat Enterprise Linux 8 기본 콘텐츠와 추가 리포지토리 콘텐츠에 액세스할 수 있어야 합니다. 달리 명시하지 않는 한 스토리지 클러스터의 모든 베어 메탈 및 컨테이너 노드에서 다음 단계를 수행합니다.

설치 중에 인터넷에 액세스할 수 없는 베어 메탈 Red Hat Ceph Storage 노드의 경우 Red Hat Satellite 서버를 사용하여 소프트웨어 콘텐츠를 제공합니다. 또는 로컬 Red Hat Enterprise Linux 8 Server ISO 이미지를 마운트하고 Red Hat Ceph Storage 노드를 ISO 이미지를 가리키도록 합니다. 자세한 내용은 Red Hat 지원에 문의하십시오.

Red Hat Satellite 서버에 Ceph 노드를 등록하는 방법에 대한 자세한 내용은 How to Register Ceph with Satellite 6 및 How to Register Ceph with the Red Hat Customer Portal 문서를 참조하십시오.

사전 요구 사항

- 유효한 Red Hat 서브스크립션.

- Red Hat Ceph Storage 노드는 인터넷에 연결할 수 있어야 함.

- Red Hat Ceph Storage 노드에 대한 루트 수준 액세스.

절차

컨테이너 배포의 경우 Red Hat Ceph Storage 노드가 배포 중에 인터넷에 액세스할 수 없는 경우입니다. 인터넷 액세스가 가능한 노드에서 먼저 다음 단계를 수행해야 합니다.

로컬 컨테이너 레지스트리를 시작합니다.

Red Hat Enterprise Linux 7

# docker run -d -p 5000:5000 --restart=always --name registry registry:2

Red Hat Enterprise Linux 8

# podman run -d -p 5000:5000 --restart=always --name registry registry:2

registry.redhat.io가 컨테이너 레지스트리 검색 경로에 있는지 확인합니다./etc/containers/registries.conf파일을 편집하려면 엽니다.[registries.search] registries = [ 'registry.access.redhat.com', 'registry.fedoraproject.org', 'registry.centos.org', 'docker.io']

registry.redhat.io가 파일에 포함되어 있지 않은 경우 추가합니다.[registries.search] registries = ['registry.redhat.io', 'registry.access.redhat.com', 'registry.fedoraproject.org', 'registry.centos.org', 'docker.io']

Red Hat Customer Portal에서 Red Hat Ceph Storage 4 이미지, Prometheus 이미지 및 대시보드 이미지를 가져옵니다.

Red Hat Enterprise Linux 7

# docker pull registry.redhat.io/rhceph/rhceph-4-rhel8:latest # docker pull registry.redhat.io/openshift4/ose-prometheus-node-exporter:v4.6 # docker pull registry.redhat.io/rhceph/rhceph-4-dashboard-rhel8:latest # docker pull registry.redhat.io/openshift4/ose-prometheus:v4.6 # docker pull registry.redhat.io/openshift4/ose-prometheus-alertmanager:v4.6

Red Hat Enterprise Linux 8

# podman pull registry.redhat.io/rhceph/rhceph-4-rhel8:latest # podman pull registry.redhat.io/openshift4/ose-prometheus-node-exporter:v4.6 # podman pull registry.redhat.io/rhceph/rhceph-4-dashboard-rhel8:latest # podman pull registry.redhat.io/openshift4/ose-prometheus:v4.6 # podman pull registry.redhat.io/openshift4/ose-prometheus-alertmanager:v4.6

참고Red Hat Enterprise Linux 7 및 8은 모두 Red Hat Enterprise Linux 8을 기반으로 동일한 컨테이너 이미지를 사용합니다.

이미지에 태그를 지정하십시오.

Prometheus 이미지 태그 버전은 Red Hat Ceph Storage 4.2의 v4.6입니다.

Red Hat Enterprise Linux 7

# docker tag registry.redhat.io/rhceph/rhceph-4-rhel8:latest LOCAL_NODE_FQDN:5000/rhceph/rhceph-4-rhel8:latest # docker tag registry.redhat.io/openshift4/ose-prometheus-node-exporter:v4.6 LOCAL_NODE_FQDN:5000/openshift4/ose-prometheus-node-exporter:v4.6 # docker tag registry.redhat.io/rhceph/rhceph-4-dashboard-rhel8:latest LOCAL_NODE_FQDN:5000/rhceph/rhceph-4-dashboard-rhel8:latest # docker tag registry.redhat.io/openshift4/ose-prometheus-alertmanager:v4.6 LOCAL_NODE_FQDN:5000/openshift4/ose-prometheus-alertmanager:v4.6 # docker tag registry.redhat.io/openshift4/ose-prometheus:v4.6 LOCAL_NODE_FQDN:5000/openshift4/ose-prometheus:v4.6

- 대체 버전

- 로컬 호스트 FQDN을 사용한 LOCAL_NODE_FQDN.

Red Hat Enterprise Linux 8

# podman tag registry.redhat.io/rhceph/rhceph-4-rhel8:latest LOCAL_NODE_FQDN:5000/rhceph/rhceph-4-rhel8:latest # podman tag registry.redhat.io/openshift4/ose-prometheus-node-exporter:v4.6 LOCAL_NODE_FQDN:5000/openshift4/ose-prometheus-node-exporter:v4.6 # podman tag registry.redhat.io/rhceph/rhceph-4-dashboard-rhel8:latest LOCAL_NODE_FQDN:5000/rhceph/rhceph-4-dashboard-rhel8:latest # podman tag registry.redhat.io/openshift4/ose-prometheus-alertmanager:v4.6 LOCAL_NODE_FQDN:5000/openshift4/ose-prometheus-alertmanager:v4.6 # podman tag registry.redhat.io/openshift4/ose-prometheus:v4.6 LOCAL_NODE_FQDN:5000/openshift4/ose-prometheus:v4.6

- 대체 버전

- 로컬 호스트 FQDN을 사용한 LOCAL_NODE_FQDN.

/etc/containers/registries.conf파일을 편집하고 파일의 포트로 노드의 FQDN을 추가하고 저장합니다.[registries.insecure] registries = ['LOCAL_NODE_FQDN:5000']참고이 단계는 로컬 Docker 레지스트리에 액세스하는 모든 스토리지 클러스터 노드에서 수행해야 합니다.

시작한 로컬 Docker 레지스트리로 이미지를 푸시합니다.

Red Hat Enterprise Linux 7

# docker push --remove-signatures LOCAL_NODE_FQDN:5000/rhceph/rhceph-4-rhel8 # docker push --remove-signatures LOCAL_NODE_FQDN:5000/openshift4/ose-prometheus-node-exporter:v4.6 # docker push --remove-signatures LOCAL_NODE_FQDN:5000/rhceph/rhceph-4-dashboard-rhel8 # docker push --remove-signatures LOCAL_NODE_FQDN:5000/openshift4/ose-prometheus-alertmanager:v4.6 # docker push --remove-signatures LOCAL_NODE_FQDN:5000/openshift4/ose-prometheus:v4.6

- 대체 버전

- 로컬 호스트 FQDN을 사용한 LOCAL_NODE_FQDN.

Red Hat Enterprise Linux 8

# podman push --remove-signatures LOCAL_NODE_FQDN:5000/rhceph/rhceph-4-rhel8 # podman push --remove-signatures LOCAL_NODE_FQDN:5000/openshift4/ose-prometheus-node-exporter:v4.6 # podman push --remove-signatures LOCAL_NODE_FQDN:5000/rhceph/rhceph-4-dashboard-rhel8 # podman push --remove-signatures LOCAL_NODE_FQDN:5000/openshift4/ose-prometheus-alertmanager:v4.6 # podman push --remove-signatures LOCAL_NODE_FQDN:5000/openshift4/ose-prometheus:v4.6

- 대체 버전

- 로컬 호스트 FQDN을 사용한 LOCAL_NODE_FQDN.

Red Hat Enterprise Linux 7의 경우

docker서비스를 다시 시작하십시오.# systemctl restart docker

모든 배포의 경우 베어 메탈 또는 컨테이너에 다음을 수행합니다.

노드를 등록하고 메시지가 표시되면 적절한 Red Hat Customer Portal 자격 증명을 입력합니다.

# subscription-manager register

CDN에서 최신 서브스크립션 데이터를 가져옵니다.

# subscription-manager refresh

Red Hat Ceph Storage에 사용 가능한 모든 서브스크립션을 나열합니다.

# subscription-manager list --available --all --matches="*Ceph*"

Red Hat Ceph Storage에 사용 가능한 서브스크립션 목록에서 Pool ID를 복사합니다.

서브스크립션을 연결합니다.

# subscription-manager attach --pool=POOL_ID- 대체 버전

- 이전 단계에서 식별한 풀 ID인 POOL_ID.

기본 소프트웨어 리포지토리를 비활성화하고 해당 Red Hat Enterprise Linux 버전에서 서버 및 추가 리포지토리를 활성화합니다.

Red Hat Enterprise Linux 7

# subscription-manager repos --disable=* # subscription-manager repos --enable=rhel-7-server-rpms # subscription-manager repos --enable=rhel-7-server-extras-rpms

Red Hat Enterprise Linux 8

# subscription-manager repos --disable=* # subscription-manager repos --enable=rhel-8-for-x86_64-baseos-rpms # subscription-manager repos --enable=rhel-8-for-x86_64-appstream-rpms

최신 패키지를 수신하도록 시스템을 업데이트합니다.

Red Hat Enterprise Linux 7의 경우:

# yum update

Red Hat Enterprise Linux 8의 경우:

# dnf update

추가 리소스

- Red Hat 서브스크립션 관리를 위한 Red Hat Subscription Manager 사용 및 구성을 참조하십시오.

- Red Hat Ceph Storage 리포지토리 활성화를 참조하십시오.

3.5. Red Hat Ceph Storage 리포지토리 활성화

Red Hat Ceph Storage를 설치하려면 먼저 설치 방법을 선택해야 합니다. Red Hat Ceph Storage는 다음 두 가지 설치 방법을 지원합니다.

CDN(Content Delivery Network)

인터넷에 직접 연결할 수 있는 Ceph Storage 클러스터의 경우 Red Hat Subscription Manager를 사용하여 필수 Ceph 리포지토리를 활성화합니다.

로컬 리포지토리

보안 조치가 인터넷에 액세스하지 못하도록 하는 Ceph Storage 클러스터의 경우 ISO 이미지로 제공되는 단일 소프트웨어 빌드에서 Red Hat Ceph Storage 4를 설치하여 로컬 리포지토리를 설치할 수 있습니다.

사전 요구 사항

- 유효한 고객 서브스크립션.

CDN 설치의 경우:

- Red Hat Ceph Storage 노드는 인터넷에 연결할 수 있어야 합니다.

- CDN에 클러스터 노드를 등록합니다.

활성화된 경우 EPEL(Extra Packages for Enterprise Linux) 소프트웨어 리포지토리를 비활성화합니다.

[root@monitor ~]# yum install yum-utils vim -y [root@monitor ~]# yum-config-manager --disable epel

절차

CDN 설치의 경우:

Ansible 관리 노드 에서 Red Hat Ceph Storage 4 Tools 리포지토리 및 Ansible 리포지토리를 활성화합니다.

Red Hat Enterprise Linux 7

[root@admin ~]# subscription-manager repos --enable=rhel-7-server-rhceph-4-tools-rpms --enable=rhel-7-server-ansible-2.9-rpms

Red Hat Enterprise Linux 8

[root@admin ~]# subscription-manager repos --enable=rhceph-4-tools-for-rhel-8-x86_64-rpms --enable=ansible-2.9-for-rhel-8-x86_64-rpms

기본적으로 Red Hat Ceph Storage 리포지토리는 해당 노드에서

ceph-ansible에 의해 활성화됩니다. 리포지토리를 수동으로 활성화하려면 다음을 수행합니다.참고컨테이너화된 배포에서 이러한 리포지토리가 필요하지 않으므로 활성화하지 마십시오.

Ceph Monitor 노드에서 Red Hat Ceph Storage 4 Monitor 리포지토리를 활성화합니다.

Red Hat Enterprise Linux 7

[root@monitor ~]# subscription-manager repos --enable=rhel-7-server-rhceph-4-mon-rpms

Red Hat Enterprise Linux 8

[root@monitor ~]# subscription-manager repos --enable=rhceph-4-mon-for-rhel-8-x86_64-rpms

Ceph OSD 노드 에서 Red Hat Ceph Storage 4 OSD 리포지토리를 활성화합니다.

Red Hat Enterprise Linux 7

[root@osd ~]# subscription-manager repos --enable=rhel-7-server-rhceph-4-osd-rpms

Red Hat Enterprise Linux 8

[root@osd ~]# subscription-manager repos --enable=rhceph-4-osd-for-rhel-8-x86_64-rpms

다음 노드 유형에서 Red Hat Ceph Storage 4 Tools 리포지토리를 활성화합니다. RBD 미러링,Ceph 클라이언트,Ceph 개체 게이트웨이,메타데이터 서버,NFS,iSCSI 게이트웨이 및 대시보드 서버.

Red Hat Enterprise Linux 7

[root@client ~]# subscription-manager repos --enable=rhel-7-server-rhceph-4-tools-rpms

Red Hat Enterprise Linux 8

[root@client ~]# subscription-manager repos --enable=rhceph-4-tools-for-rhel-8-x86_64-rpms

ISO 설치의 경우:

- Red Hat 고객 포털에 로그인합니다.

- 다운로드를 클릭하여 소프트웨어 및 다운로드 센터를 방문하십시오.

- Red Hat Ceph Storage 영역에서 소프트웨어 다운로드를 클릭하여 최신 버전의 소프트웨어를 다운로드합니다.

추가 리소스

- Red Hat 서브스크립션 관리 1에 대한 Red Hat Subscription Manager 사용 및 구성 가이드

3.6. Red Hat Ceph Storage의 네트워크 구성 확인

모든 Red Hat Ceph Storage 노드에는 공용 네트워크가 필요합니다. Ceph 클라이언트가 Ceph 모니터 및 Ceph OSD 노드에 연결할 수 있는 공용 네트워크에 네트워크 인터페이스 카드가 구성되어 있어야 합니다.

Ceph가 공용 네트워크와 분리된 네트워크에서 제어, 피어링, 복제 및 복구할 수 있도록 클러스터 네트워크용 네트워크 인터페이스 카드가 있을 수 있습니다.

네트워크 인터페이스 설정을 구성하고 변경 사항을 영구적으로 수행해야 합니다.

Red Hat은 공용 및 사설 네트워크 모두에 단일 네트워크 인터페이스 카드를 사용하지 않는 것이 좋습니다.

사전 요구 사항

- 네트워크에 연결된 네트워크 인터페이스 카드입니다.

절차

스토리지 클러스터의 모든 Red Hat Ceph Storage 노드에서 root 사용자로 다음 단계를 수행합니다.

/etc/sysconfig/network-scripts/ifcfg-*파일에 공용 네트워크 인터페이스 카드에 해당하는 다음 설정이 있는지 확인합니다.-

BOOTPROTO매개변수는 고정 IP 주소에 대해none으로 설정됩니다. ONBOOT매개변수를yes로 설정해야 합니다.이 값이

no로 설정되면 재부팅 시 Ceph 스토리지 클러스터가 피어링되지 않을 수 있습니다.IPv6 주소를 사용하려는 경우

IPV6INIT와 같은 IPv6 매개변수를IPV6_FAILURE_FATAL매개변수를 제외하고yes로 설정해야 합니다.또한 Ceph 구성 파일

/etc/ceph/ceph.conf를 편집하여 Ceph에 IPv6를 사용하도록 지시하고, Ceph는 IPv4를 사용합니다.

-

추가 리소스

- Red Hat Enterprise Linux 8에 대한 네트워크 인터페이스 스크립트 구성에 대한 자세한 내용은 Red Hat Enterprise Linux 8 네트워킹 구성 가이드의 ifcfg 파일로 IP 네트워킹 구성 장을 참조하십시오.

- 네트워크 구성에 대한 자세한 내용은 Red Hat Ceph Storage 4용 구성 가이드 의 Ceph 네트워크 구성 섹션을 참조하십시오.

3.7. Red Hat Ceph Storage의 방화벽 설정

Red Hat Ceph Storage는 firewalld 서비스를 사용합니다. firewalld 서비스에는 각 데몬의 포트 목록이 포함되어 있습니다.

Ceph 모니터 데몬은 Ceph 스토리지 클러스터 내에서의 통신에 포트 3300 및 6789 를 사용합니다.

각 Ceph OSD 노드에서 OSD 데몬은 범위 6800-7300 의 여러 포트를 사용합니다.

- 클라이언트와 통신하고 공용 네트워크를 통해 모니터링하기 위한 하나

- 클러스터 네트워크를 통해 다른 OSD로 데이터를 전송하는 방법(사용 가능한 경우), 공용 네트워크를 통해 데이터 전송

- 클러스터 네트워크를 통해 하트비트 패킷의 교환, 사용 가능한 경우; 그렇지 않으면 공용 네트워크를 통해

Ceph Manager(ceph-mgr) 데몬은 범위 6800-7300 의 포트를 사용합니다. 동일한 노드에서 Ceph Monitors를 사용하여 ceph-mgr 데몬을 조정하는 것이 좋습니다.

Ceph Metadata Server 노드(ceph-mds)는 포트 범위 6800-7300 을 사용합니다.

Ceph Object Gateway 노드는 기본적으로 포트 8080 을 사용하도록 Ansible에서 구성합니다. 그러나 기본 포트(예: 포트 80 )를 변경할 수 있습니다.

SSL/TLS 서비스를 사용하려면 포트 443 을 엽니다.

firewalld 가 활성화된 경우 다음 단계는 선택 사항입니다. 기본적으로 ceph-ansible 에는 group_vars/all.yml 의 아래 설정이 포함되어 있으며 해당 포트가 자동으로 열립니다.

configure_firewall: True

사전 요구 사항

- 네트워크 하드웨어가 연결되어 있습니다.

-

스토리지 클러스터의 모든 노드에

root또는sudo액세스 권한을 부여합니다.

절차

스토리지 클러스터의 모든 노드에서

firewalld서비스를 시작합니다. 부팅 시 실행되도록 활성화하고 실행 중인지 확인합니다.# systemctl enable firewalld # systemctl start firewalld # systemctl status firewalld

모든 모니터 노드에서 공용 네트워크에서 포트

3300및6789를 엽니다.[root@monitor ~]# firewall-cmd --zone=public --add-port=3300/tcp [root@monitor ~]# firewall-cmd --zone=public --add-port=3300/tcp --permanent [root@monitor ~]# firewall-cmd --zone=public --add-port=6789/tcp [root@monitor ~]# firewall-cmd --zone=public --add-port=6789/tcp --permanent [root@monitor ~]# firewall-cmd --permanent --add-service=ceph-mon [root@monitor ~]# firewall-cmd --add-service=ceph-mon

소스 주소를 기반으로 액세스를 제한하려면 다음을 수행합니다.

firewall-cmd --zone=public --add-rich-rule='rule family=ipv4 \ source address=IP_ADDRESS/NETMASK_PREFIX port protocol=tcp \ port=6789 accept' --permanent

- 대체 버전

- 모니터 노드의 네트워크 주소가 있는 IP_ADDRESS.

CIDR 표기법의 넷마스크가 포함된 NETMASK_PREFIX

예제

[root@monitor ~]# firewall-cmd --zone=public --add-rich-rule='rule family=ipv4 \ source address=192.168.0.11/24 port protocol=tcp \ port=6789 accept' --permanent

모든 OSD 노드에서 공용 네트워크에서 포트

6800-7300을 엽니다.[root@osd ~]# firewall-cmd --zone=public --add-port=6800-7300/tcp [root@osd ~]# firewall-cmd --zone=public --add-port=6800-7300/tcp --permanent [root@osd ~]# firewall-cmd --permanent --add-service=ceph [root@osd ~]# firewall-cmd --add-service=ceph

별도의 클러스터 네트워크가 있는 경우 적절한 영역을 사용하여 명령을 반복합니다.

모든 Ceph Manager(

ceph-mgr) 노드에서 공용 네트워크에서 포트6800-7300을 엽니다.[root@monitor ~]# firewall-cmd --zone=public --add-port=6800-7300/tcp [root@monitor ~]# firewall-cmd --zone=public --add-port=6800-7300/tcp --permanent

별도의 클러스터 네트워크가 있는 경우 적절한 영역을 사용하여 명령을 반복합니다.

모든 Ceph Metadata Server(

ceph-mds) 노드에서 공용 네트워크에서 포트6800-7300을 엽니다.[root@monitor ~]# firewall-cmd --zone=public --add-port=6800-7300/tcp [root@monitor ~]# firewall-cmd --zone=public --add-port=6800-7300/tcp --permanent

별도의 클러스터 네트워크가 있는 경우 적절한 영역을 사용하여 명령을 반복합니다.

모든 Ceph Object Gateway 노드에서 공용 네트워크에서 관련 포트 또는 포트를 엽니다.

기본 Ansible 구성 포트

8080을 시작하려면 다음을 수행합니다.[root@gateway ~]# firewall-cmd --zone=public --add-port=8080/tcp [root@gateway ~]# firewall-cmd --zone=public --add-port=8080/tcp --permanent

소스 주소를 기반으로 액세스를 제한하려면 다음을 수행합니다.

firewall-cmd --zone=public --add-rich-rule="rule family="ipv4" \ source address="IP_ADDRESS/NETMASK_PREFIX" port protocol="tcp" \ port="8080" accept"

firewall-cmd --zone=public --add-rich-rule="rule family="ipv4" \ source address="IP_ADDRESS/NETMASK_PREFIX" port protocol="tcp" \ port="8080" accept" --permanent

- 대체 버전

- 모니터 노드의 네트워크 주소가 있는 IP_ADDRESS.

CIDR 표기법의 넷마스크가 포함된 NETMASK_PREFIX

예제

[root@gateway ~]# firewall-cmd --zone=public --add-rich-rule="rule family="ipv4" \ source address="192.168.0.31/24" port protocol="tcp" \ port="8080" accept"

[root@gateway ~]# firewall-cmd --zone=public --add-rich-rule="rule family="ipv4" \ source address="192.168.0.31/24" port protocol="tcp" \ port="8080" accept" --permanent

선택적으로 Ansible을 사용하여 Ceph Object Gateway를 설치하고 Ansible이

8080에서 포트80으로 사용할 Ceph Object Gateway를 구성하는 기본 포트를 변경한 경우, 이 포트를 엽니다.[root@gateway ~]# firewall-cmd --zone=public --add-port=80/tcp [root@gateway ~]# firewall-cmd --zone=public --add-port=80/tcp --permanent

소스 주소에 따라 액세스를 제한하려면 다음 명령을 실행합니다.

firewall-cmd --zone=public --add-rich-rule="rule family="ipv4" \ source address="IP_ADDRESS/NETMASK_PREFIX" port protocol="tcp" \ port="80" accept"

firewall-cmd --zone=public --add-rich-rule="rule family="ipv4" \ source address="IP_ADDRESS/NETMASK_PREFIX" port protocol="tcp" \ port="80" accept" --permanent

- 대체 버전

- 모니터 노드의 네트워크 주소가 있는 IP_ADDRESS.

- CIDR 표기법의 넷마스크가 포함된 NETMASK_PREFIX

예제

[root@gateway ~]# firewall-cmd --zone=public --add-rich-rule="rule family="ipv4" \ source address="192.168.0.31/24" port protocol="tcp" \ port="80" accept"

[root@gateway ~]# firewall-cmd --zone=public --add-rich-rule="rule family="ipv4" \ source address="192.168.0.31/24" port protocol="tcp" \ port="80" accept" --permanent

선택 사항: SSL/TLS를 사용하려면 포트

443을 엽니다.[root@gateway ~]# firewall-cmd --zone=public --add-port=443/tcp [root@gateway ~]# firewall-cmd --zone=public --add-port=443/tcp --permanent

소스 주소에 따라 액세스를 제한하려면 다음 명령을 실행합니다.

firewall-cmd --zone=public --add-rich-rule="rule family="ipv4" \ source address="IP_ADDRESS/NETMASK_PREFIX" port protocol="tcp" \ port="443" accept"

firewall-cmd --zone=public --add-rich-rule="rule family="ipv4" \ source address="IP_ADDRESS/NETMASK_PREFIX" port protocol="tcp" \ port="443" accept" --permanent

- 대체 버전

- 모니터 노드의 네트워크 주소가 있는 IP_ADDRESS.

- CIDR 표기법의 넷마스크가 포함된 NETMASK_PREFIX

예제

[root@gateway ~]# firewall-cmd --zone=public --add-rich-rule="rule family="ipv4" \ source address="192.168.0.31/24" port protocol="tcp" \ port="443" accept" [root@gateway ~]# firewall-cmd --zone=public --add-rich-rule="rule family="ipv4" \ source address="192.168.0.31/24" port protocol="tcp" \ port="443" accept" --permanent

추가 리소스

- 공용 및 클러스터 네트워크에 대한 자세한 내용은 Red Hat Ceph Storage의 네트워크 구성 확인을 참조하십시오.

-

firewalld에 대한 자세한 내용은 Red Hat Enterprise Linux 8용 네트워크 보안 가이드의 방화벽 사용 및 구성 장을 참조하십시오.

3.8. sudo 액세스를 사용하여 Ansible 사용자 생성

Ansible은 소프트웨어를 설치하고 암호를 묻지 않고 구성 파일을 생성할 수 있는 루트 권한이 있는 사용자로 모든 Red Hat Ceph Storage(RHCS) 노드에 로그인할 수 있어야 합니다. Ansible을 사용하여 Red Hat Ceph Storage 클러스터를 배포하고 구성할 때 스토리지 클러스터의 모든 노드에 암호가 없는 root 액세스 권한이 있는 Ansible 사용자를 생성해야 합니다.

사전 요구 사항

-

스토리지 클러스터의 모든 노드에

root또는sudo액세스 권한을 부여합니다.

절차

root사용자로 노드에 로그인합니다.ssh root@HOST_NAME- 대체 버전

HOST_NAME 및 Ceph 노드의 호스트 이름입니다.

예제

# ssh root@mon01

메시지가 표시되면

root암호를 입력합니다.

새 Ansible 사용자를 생성합니다.

adduser USER_NAME- 대체 버전

USER_NAME - Ansible 사용자의 새 사용자 이름입니다.

예제

# adduser admin

중요ceph를 사용자 이름으로 사용하지 마십시오.ceph사용자 이름은 Ceph 데몬용으로 예약되어 있습니다. 클러스터 전체의 균일한 사용자 이름은 쉽게 사용할 수 있지만 일반적으로 무차별 공격에 사용되므로 명확한 사용자 이름을 사용하지 않도록 합니다.

이 사용자의 새 암호를 설정합니다.

# passwd USER_NAME- 대체 버전

USER_NAME - Ansible 사용자의 새 사용자 이름입니다.

예제

# passwd admin

메시지가 표시되면 새 암호를 두 번 입력합니다.

새로 생성된 사용자에 대해

sudo액세스를 설정합니다.cat << EOF >/etc/sudoers.d/USER_NAME $USER_NAME ALL = (root) NOPASSWD:ALL EOF- 대체 버전

USER_NAME - Ansible 사용자의 새 사용자 이름입니다.

예제

# cat << EOF >/etc/sudoers.d/admin admin ALL = (root) NOPASSWD:ALL EOF

새 파일에 올바른 파일 권한을 할당합니다.

chmod 0440 /etc/sudoers.d/USER_NAME- 대체 버전

USER_NAME - Ansible 사용자의 새 사용자 이름입니다.

예제

# chmod 0440 /etc/sudoers.d/admin

추가 리소스

- 기본 시스템 설정 구성 가이드 Red Hat Enterprise Linux 8의 사용자 계정 관리 섹션

3.9. Ansible에 대해 암호 없는 SSH 활성화

Ansible 관리 노드에서 SSH 키 쌍을 생성하고, 암호를 입력하라는 메시지가 표시되지 않고 Ansible이 노드에 액세스할 수 있도록 스토리지 클러스터의 각 노드에 공개 키를 배포합니다.

Cockpit 웹 기반 인터페이스를 사용하여 Red Hat Ceph Storage를 설치하는 경우에는 이 절차가 필요하지 않습니다. Cockpit Ceph 설치 프로그램이 자체 SSH 키를 생성하기 때문입니다. Cockpit SSH 키를 클러스터의 모든 노드에 복사하는 방법은 Cockpit 웹 인터페이스를 사용하여 Red Hat Ceph Storage 설치 장에 있습니다.

사전 요구 사항

- Ansible 관리 노드에 액세스

-

sudo액세스 권한을 사용하여 Ansible 사용자 만들기.

절차

SSH 키 쌍을 생성하고 기본 파일 이름을 수락하고 암호를 비워 둡니다.

[ansible@admin ~]$ ssh-keygen

공개 키를 스토리지 클러스터의 모든 노드에 복사합니다.

ssh-copy-id USER_NAME@HOST_NAME

- 대체 버전

- USER_NAME - Ansible 사용자의 새 사용자 이름입니다.

HOST_NAME 및 Ceph 노드의 호스트 이름입니다.

예제

[ansible@admin ~]$ ssh-copy-id ceph-admin@ceph-mon01

사용자의 SSH

config파일을 생성합니다.[ansible@admin ~]$ touch ~/.ssh/config

config파일을 편집하려면 을 엽니다. 스토리지 클러스터의 각 노드에 대한Hostname및User옵션의 값을 설정합니다.Host node1 Hostname HOST_NAME User USER_NAME Host node2 Hostname HOST_NAME User USER_NAME ...

- 대체 버전

- HOST_NAME 및 Ceph 노드의 호스트 이름입니다.

USER_NAME - Ansible 사용자의 새 사용자 이름입니다.

예제

Host node1 Hostname monitor User admin Host node2 Hostname osd User admin Host node3 Hostname gateway User admin

중요~/.ssh/config파일을 구성하면ansible-playbook명령을 실행할 때마다-u USER_NAME옵션을 지정할 필요가 없습니다.

~/.ssh/config파일에 대한 올바른 파일 권한을 설정합니다.[admin@admin ~]$ chmod 600 ~/.ssh/config

추가 리소스

-

ssh_config(5)매뉴얼 페이지. - Red Hat Enterprise Linux 8용 네트워크 보안 의 OpenSSH를 사용하여 두 시스템 간에 보안 통신 사용 장을 참조하십시오.

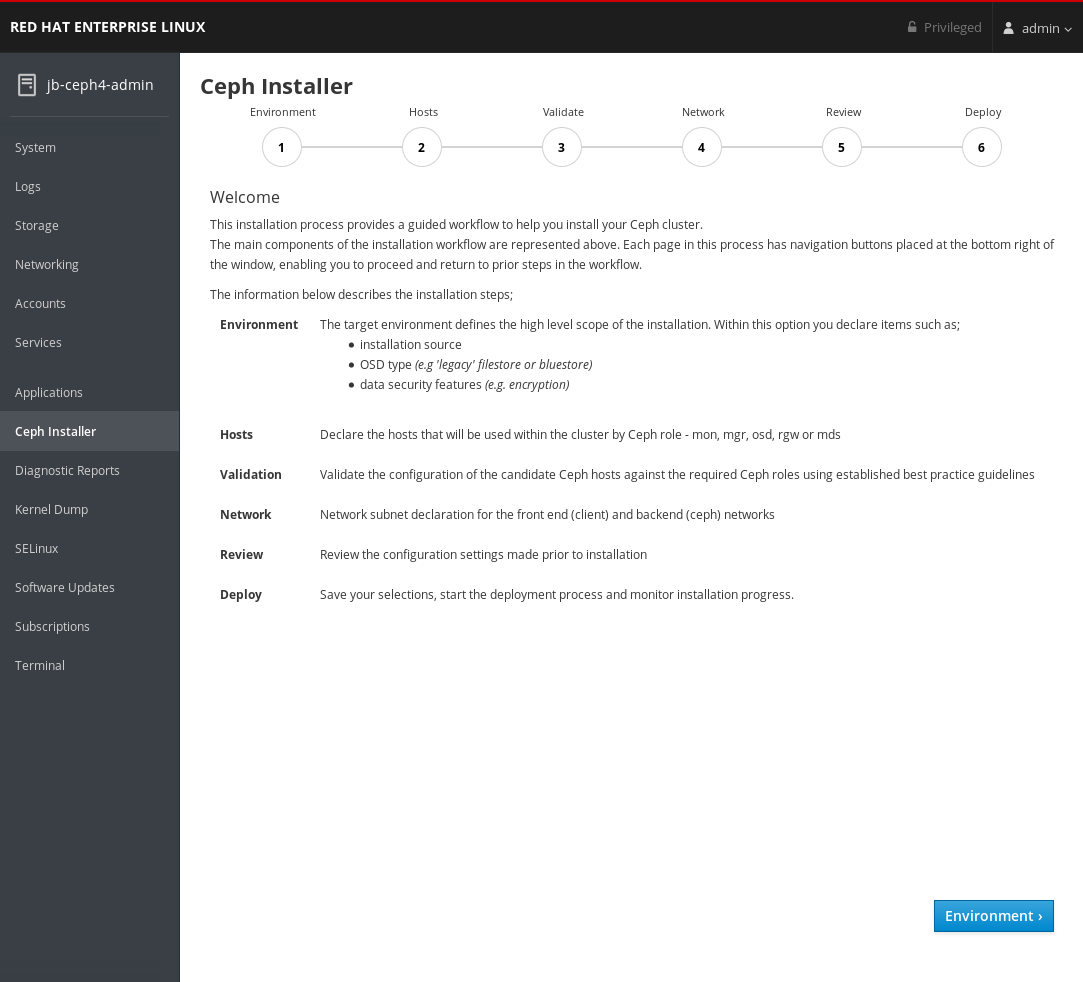

4장. Cockpit 웹 인터페이스를 사용하여 Red Hat Ceph Storage 설치

이 장에서는 Cockpit 웹 기반 인터페이스를 사용하여 Red Hat Ceph Storage 클러스터 및 메타데이터 서버, Ceph 클라이언트 또는 Ceph Object Gateway와 같은 기타 구성 요소를 설치하는 방법을 설명합니다.

이 프로세스는 Cockpit Ceph 설치 프로그램 설치, Cockpit에 로그인한 후 설치 프로그램 내의 다른 페이지를 사용하여 클러스터 설치 구성 및 시작으로 구성됩니다.

Cockpit Ceph 설치 프로그램은 Ansible 및 ceph-ansible RPM에서 제공하는 Ansible 플레이북을 사용하여 실제 설치를 수행합니다. Cockpit 없이 이러한 플레이북을 사용하여 Ceph를 설치할 수 있습니다. 해당 프로세스는 이 장과 관련이 있으며 직접 Ansible 설치 또는 Ansible 플레이북을 직접 사용하는 것입니다.

Cockpit Ceph 설치 프로그램은 현재 IPv6 네트워킹을 지원하지 않습니다. IPv6 네트워킹이 필요한 경우 Ansible 플레이북을 사용하여 Ceph를 직접 설치합니다.

Ceph의 관리 및 모니터링에 사용되는 대시보드 웹 인터페이스는 기본적으로 Cockpit이 백엔드에서 사용하는 ceph-ansible RPM의 Ansible 플레이북에서 설치됩니다. 따라서 Ansible 플레이북을 직접 사용하거나 Cockpit을 사용하여 Ceph를 설치할 때 대시보드 웹 인터페이스도 설치됩니다.

4.1. 사전 요구 사항

- Ansible Red Hat Ceph Storage를 직접 설치하는 데 필요한 일반 사전 요구 사항을 완료합니다.

- Firefox 또는 Chrome 최신 버전입니다.

- 다중 네트워크를 사용하여 클러스터 내부 트래픽, 클라이언트 간 트래픽, RADOS Gateway 트래픽 또는 iSCSI 트래픽을 세그먼트하는 경우 관련 네트워크가 이미 호스트에 이미 구성되어 있는지 확인합니다. 자세한 내용은 Cockpit Ceph 설치 프로그램의 네트워크 페이지 완료에 대한 하드웨어 가이드 의 네트워크 고려 사항 및 이 장에 있는 섹션을참조하십시오.

-

Cockpit 웹 기반 인터페이스의 기본 포트(

9090)에 액세스할 수 있는지 확인합니다.

4.2. 설치 요구사항

- Ansible 관리 노드로 작동할 노드 1개입니다.

- 성능 지표 및 경고 플랫폼을 제공하는 하나의 노드입니다. 이는 Ansible 관리 노드와 함께 배치될 수 있습니다.

- Ceph 클러스터를 구성하는 하나 이상의 노드입니다. 설치 프로그램은 개발/POC 라는 올인원 설치를 지원합니다. 이 모드에서는 모든 Ceph 서비스를 동일한 노드에서 실행할 수 있으며 데이터 복제는 기본적으로 호스트 수준 보호가 아닌 디스크로 설정됩니다.

4.3. Cockpit Ceph 설치 및 구성

Cockpit Ceph 설치 프로그램을 사용하여 Red Hat Ceph Storage 클러스터를 설치하려면 먼저 Ansible 관리 노드에 Cockpit Ceph 설치 프로그램을 설치해야 합니다.

사전 요구 사항

- Ansible 관리 노드에 대한 루트 수준 액세스.

-

Ansible 애플리케이션과 함께 사용할

ansible사용자 계정입니다.

절차

Cockpit이 설치되었는지 확인합니다.

$ rpm -q cockpit

예제:

[admin@jb-ceph4-admin ~]$ rpm -q cockpit cockpit-196.3-1.el8.x86_64

위의 예제와 유사한 출력이 표시되면 Cockpit 확인 단계로 건너뜁니다. 출력이

package cockpit이 설치되지 않은경우 Cockpit 설치 단계를 계속합니다.선택 사항: Cockpit을 설치합니다.

Red Hat Enterprise Linux 8의 경우:

# dnf install cockpit

Red Hat Enterprise Linux 7의 경우:

# yum install cockpit

Cockpit이 실행 중인지 확인합니다.

# systemctl status cockpit.socket

출력에

Active: active(가져오기)가 표시되면 Red Hat Ceph Storage용 Cockpit 플러그인 설치 단계로 건너뜁니다.Active: inactive(dead)가 표시되는 경우 Cockpit 활성화 단계를 계속 진행합니다.선택 사항: Cockpit을 활성화합니다.

systemctl명령을 사용하여 Cockpit을 활성화합니다.# systemctl enable --now cockpit.socket

다음과 같은 행이 표시됩니다.

Created symlink /etc/systemd/system/sockets.target.wants/cockpit.socket → /usr/lib/systemd/system/cockpit.socket.

Cockpit이 실행 중인지 확인합니다.

# systemctl status cockpit.socket

다음과 같은 행이 표시됩니다.

Active: active (listening) since Tue 2020-01-07 18:49:07 EST; 7min ago

Red Hat Ceph Storage용 Cockpit Ceph Installer를 설치합니다.

Red Hat Enterprise Linux 8의 경우:

# dnf install cockpit-ceph-installer

Red Hat Enterprise Linux 7의 경우:

# yum install cockpit-ceph-installer

Ansible 사용자로 sudo를 사용하여 컨테이너 카탈로그에 로그인합니다.

참고기본적으로 Cockpit Ceph 설치 프로그램은

root사용자를 사용하여 Ceph를 설치합니다. 사전 요구 사항의 일부로 생성된 Ansible 사용자를 사용하여 Ceph를 설치하려면 Ansible 사용자로sudo를 사용하여 이 절차의 나머지 명령을 실행합니다.Red Hat Enterprise Linux 7

$ sudo docker login -u CUSTOMER_PORTAL_USERNAME https://registry.redhat.io예제

[admin@jb-ceph4-admin ~]$ sudo docker login -u myusername https://registry.redhat.io Password: Login Succeeded!

Red Hat Enterprise Linux 8

$ sudo podman login -u CUSTOMER_PORTAL_USERNAME https://registry.redhat.io예제

[admin@jb-ceph4-admin ~]$ sudo podman login -u myusername https://registry.redhat.io Password: Login Succeeded!

registry.redhat.io가 컨테이너 레지스트리 검색 경로에 있는지 확인합니다./etc/containers/registries.conf파일을 편집하려면 엽니다.[registries.search] registries = [ 'registry.access.redhat.com', 'registry.fedoraproject.org', 'registry.centos.org', 'docker.io']

registry.redhat.io가 파일에 포함되어 있지 않은 경우 추가합니다.[registries.search] registries = ['registry.redhat.io', 'registry.access.redhat.com', 'registry.fedoraproject.org', 'registry.centos.org', 'docker.io']

Ansible 사용자로 sudo를 사용하여

ansible-runner-service를 시작합니다.$ sudo ansible-runner-service.sh -s

예제

[admin@jb-ceph4-admin ~]$ sudo ansible-runner-service.sh -s Checking environment is ready Checking/creating directories Checking SSL certificate configuration Generating RSA private key, 4096 bit long modulus (2 primes) ..................................................................................................................................................................................................................................++++ ......................................................++++ e is 65537 (0x010001) Generating RSA private key, 4096 bit long modulus (2 primes) ........................................++++ ..............................................................................................................................................................................++++ e is 65537 (0x010001) writing RSA key Signature ok subject=C = US, ST = North Carolina, L = Raleigh, O = Red Hat, OU = RunnerServer, CN = jb-ceph4-admin Getting CA Private Key Generating RSA private key, 4096 bit long modulus (2 primes) .....................................................................................................++++ ..++++ e is 65537 (0x010001) writing RSA key Signature ok subject=C = US, ST = North Carolina, L = Raleigh, O = Red Hat, OU = RunnerClient, CN = jb-ceph4-admin Getting CA Private Key Setting ownership of the certs to your user account(admin) Setting target user for ansible connections to admin Applying SELINUX container_file_t context to '/etc/ansible-runner-service' Applying SELINUX container_file_t context to '/usr/share/ceph-ansible' Ansible API (runner-service) container set to rhceph/ansible-runner-rhel8:latest Fetching Ansible API container (runner-service). Please wait... Trying to pull registry.redhat.io/rhceph/ansible-runner-rhel8:latest...Getting image source signatures Copying blob c585fd5093c6 done Copying blob 217d30c36265 done Copying blob e61d8721e62e done Copying config b96067ea93 done Writing manifest to image destination Storing signatures b96067ea93c8d6769eaea86854617c63c61ea10c4ff01ecf71d488d5727cb577 Starting Ansible API container (runner-service) Started runner-service container Waiting for Ansible API container (runner-service) to respond The Ansible API container (runner-service) is available and responding to requests Login to the cockpit UI at https://jb-ceph4-admin:9090/cockpit-ceph-installer to start the install

출력의 마지막 행에는 Cockpit Ceph 설치 프로그램에 대한 URL이 포함됩니다. 위의 예에서 URL은

https://jb-ceph4-admin:9090/cockpit-ceph-installer입니다. 사용자 환경에 인쇄된 URL을 기록해 두십시오.

4.4. Cockpit Ceph Installer SSH 키를 클러스터의 모든 노드에 복사

Cockpit Ceph 설치 프로그램은 SSH를 사용하여 클러스터에 노드를 연결하고 구성합니다. 이를 위해 설치 프로그램이 자동으로 SSH 키 쌍을 생성하므로 암호를 입력하라는 메시지가 표시되지 않고 노드에 액세스할 수 있습니다. SSH 공개 키는 클러스터의 모든 노드로 전송되어야 합니다.

사전 요구 사항

- sudo 액세스 권한이 있는 Ansible 사용자가 생성되었습니다.

- Cockpit Ceph 설치 프로그램이 설치 및 구성되어 있습니다.

절차

Ansible 관리 노드에 Ansible 사용자로 로그인합니다.

ssh ANSIBLE_USER@HOST_NAME

예제:

$ ssh admin@jb-ceph4-admin

SSH 공개 키를 첫 번째 노드에 복사합니다.

sudo ssh-copy-id -f -i /usr/share/ansible-runner-service/env/ssh_key.pub _ANSIBLE_USER_@_HOST_NAME_

예제:

$ sudo ssh-copy-id -f -i /usr/share/ansible-runner-service/env/ssh_key.pub admin@jb-ceph4-mon /bin/ssh-copy-id: INFO: Source of key(s) to be installed: "/usr/share/ansible-runner-service/env/ssh_key.pub" admin@192.168.122.182's password: Number of key(s) added: 1 Now try logging into the machine, with: "ssh 'admin@jb-ceph4-mon'" and check to make sure that only the key(s) you wanted were added.

클러스터의 모든 노드에 대해 이 단계를 반복합니다.

4.5. Cockpit에 로그인합니다.

Cockpit에 로그인하면 Cockpit Ceph 설치 프로그램 웹 인터페이스를 볼 수 있습니다.

사전 요구 사항

- Cockpit Ceph 설치 프로그램이 설치 및 구성되어 있습니다.

- Cockpit Ceph 설치 프로그램 구성의 일부로 URL이 인쇄되어 있습니다.

절차

웹 브라우저에서 URL을 엽니다.

Ansible 사용자 이름과 암호를 입력합니다.

권한 있는 작업에 내 암호를 다시 사용하기 위한 라디오 버튼을 클릭합니다.

Log In 을 클릭합니다.

시작 페이지를 검토하여 설치 관리자의 작동 방식 및 설치 프로세스의 전반적인 흐름을 확인합니다.

시작 페이지의 정보를 검토한 후 웹 페이지의 오른쪽 아래에 있는 환경 버튼을 클릭합니다.

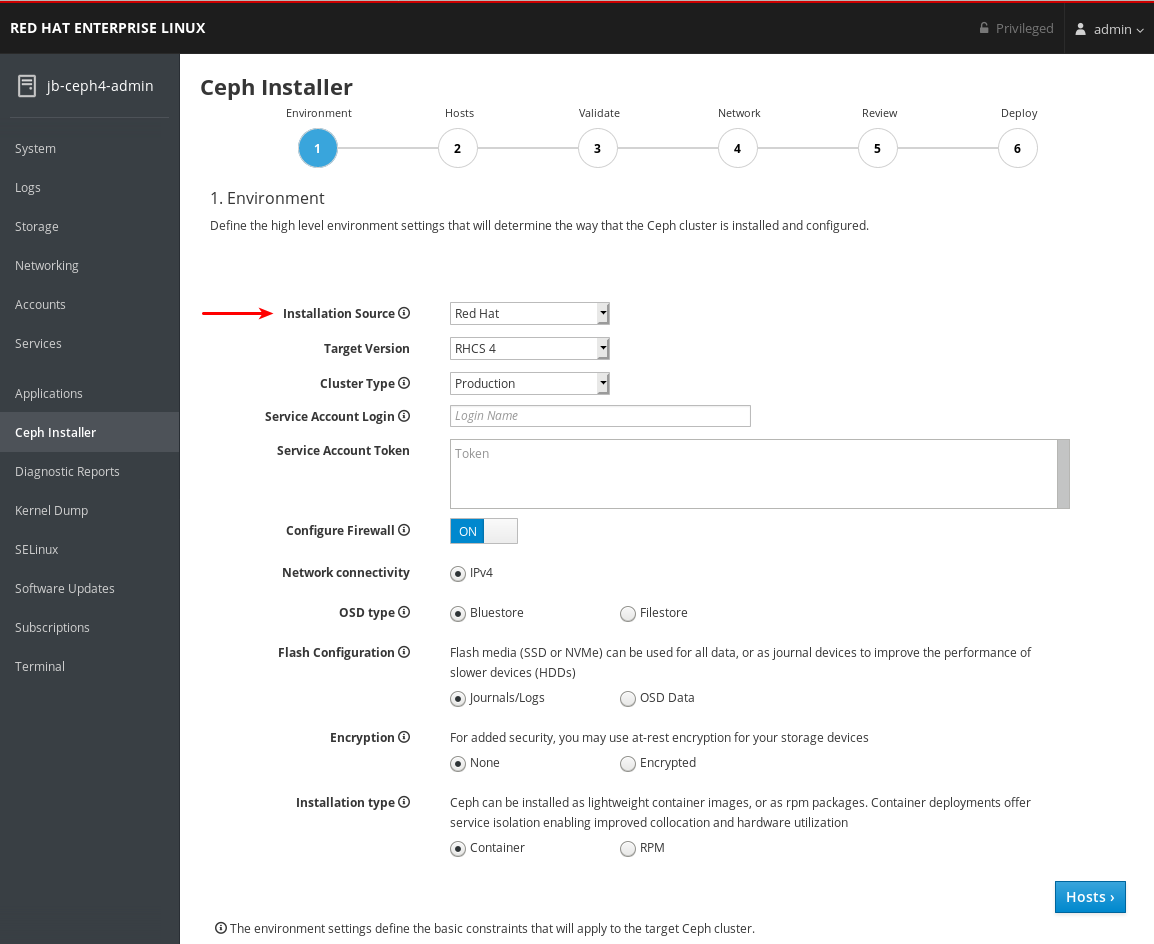

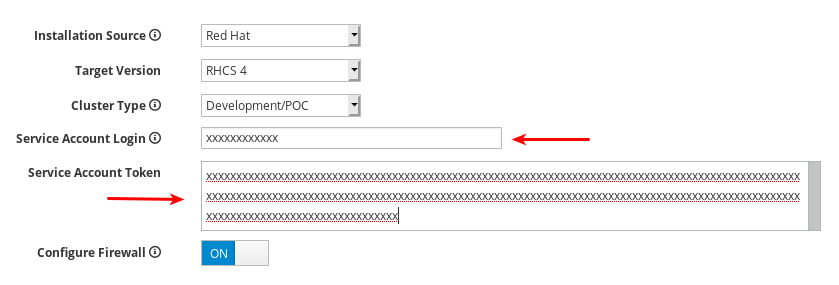

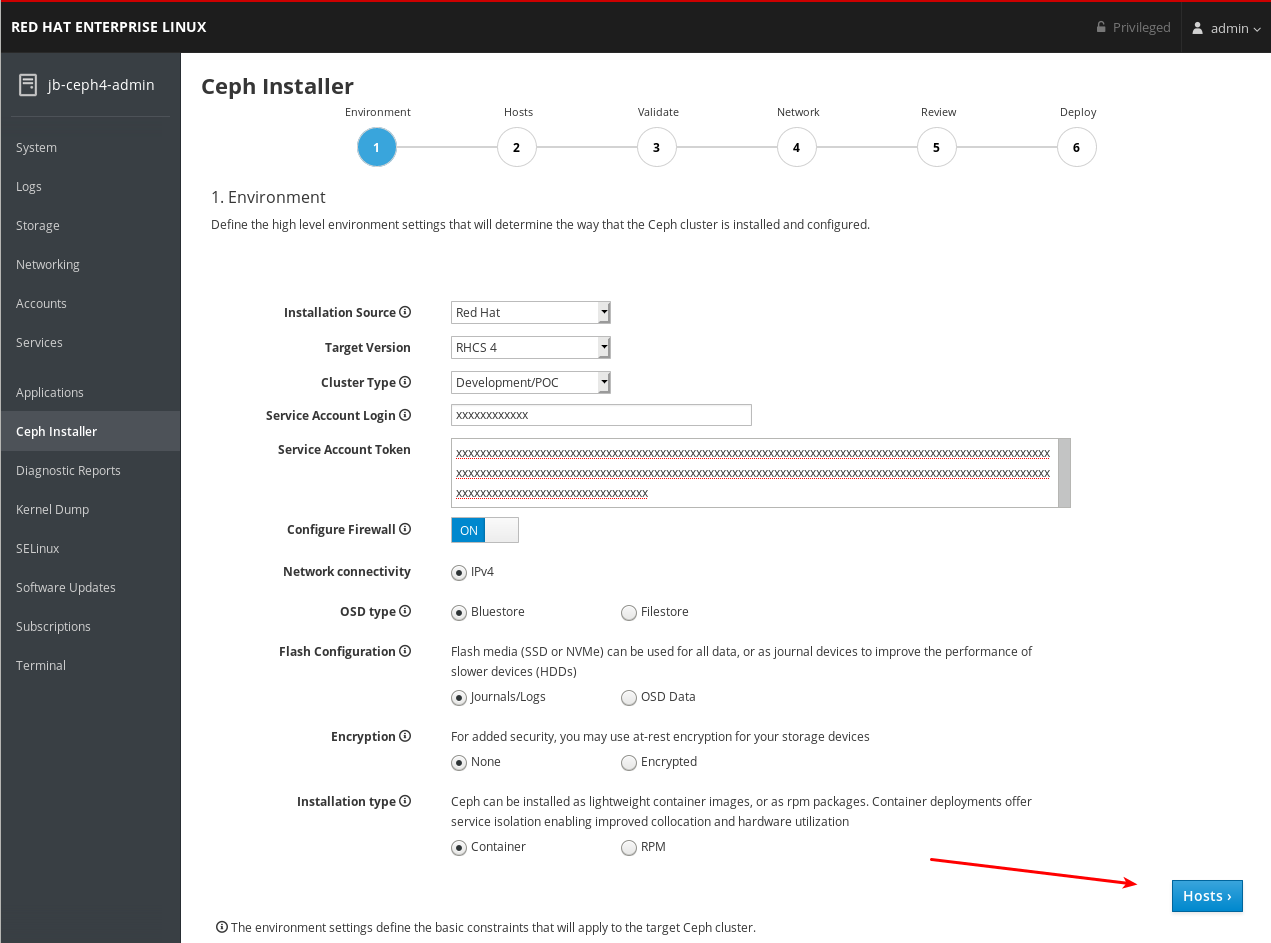

4.6. Cockpit Ceph 설치 프로그램의 환경 페이지 완료

환경 페이지를 사용하면 사용할 설치 소스 및 스토리지에 하드 디스크 드라이브(HDD) 및 Solid State Drives(SSD)를 사용하는 방법과 같이 클러스터의 전반적인 측면을 구성할 수 있습니다.

사전 요구 사항

- Cockpit Ceph 설치 프로그램이 설치 및 구성되어 있습니다.

- Cockpit Ceph 설치 프로그램 구성의 일부로 URL이 인쇄됩니다.

- 레지스트리 서비스 계정 을 생성했습니다.

따를 대화 상자에 일부 설정의 오른쪽에는 툴팁이 있습니다. 이를 보려면 점선을 가진 i 와 같은 아이콘 위에 마우스 커서를 올려 놓습니다.

절차

설치 소스를 선택합니다. Red Hat Subscription Manager 또는 ISO에서 리포지토리를 사용하여 Red Hat 고객 포털에서 다운로드한 CD 이미지를 사용합니다.

Red Hat 을 선택하면 다른 옵션 없이Target Version 이 RHCS 4 로 설정됩니다. ISO 를 선택하면대상 버전이 ISO 이미지 파일로 설정됩니다.

중요ISO를 선택하는 경우 이미지 파일이

/usr/share/ansible-runner-service/iso디렉터리에 있어야 하며 SELinux 컨텍스트를container_file_t로 설정해야 합니다.중요설치 소스에 대한 커뮤니티 및 배포 옵션은 지원되지 않습니다.

클러스터 유형을 선택합니다. CPU 번호 및 메모리 크기와 같은 특정 리소스 요구 사항이 충족되지 않는 경우 프로덕션 선택을 통해 설치가 진행되지 않습니다. 리소스 요구 사항이 충족되지 않는 경우에도 클러스터 설치를 허용하려면 Development/POC 를 선택합니다.

중요

중요프로덕션에서 사용할 Ceph 클러스터를 설치하는 데 Development/POC 모드를 사용하지 마십시오.

서비스 계정 로그인 및 서비스 계정 토큰 설정. Red Hat Registry Service 계정이 없는 경우 레지스트리 서비스 계정 웹 페이지를 사용하여 생성합니다.

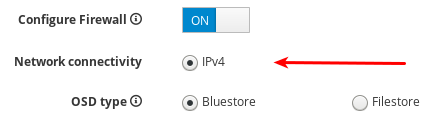

Configure Firewall 을 ON 으로 설정하여

firewalld에 규칙을 적용하여 Ceph 서비스의 포트를 엽니다.firewalld를 사용하지 않는 경우 OFF 설정을 사용합니다.

현재 Cockpit Ceph 설치 프로그램은 IPv4만 지원합니다. IPv6 지원이 필요한 경우 Cockpit Ceph Installer를 그대로 사용하고 Ansible 스크립트를 사용하여 Ceph 설치를 진행합니다.

OSD 유형을 BlueStore 또는 FileStore 로 설정합니다.

중요

중요bluestore가 기본 OSD 유형입니다. 이전에는 Ceph에서 FileStore를 오브젝트 저장소로 사용했습니다. BlueStore는 더 많은 기능과 향상된 성능을 제공하기 때문에 이 형식은 새로운 Red Hat Ceph Storage 4.0 설치에서 더 이상 사용되지 않습니다. FileStore를 계속 사용할 수는 있지만 이를 사용하려면 지원 예외가 필요합니다. BlueStore에 대한 자세한 내용은 아키텍처 가이드의 Ceph BlueStore 를 참조하십시오.

Flash Configuration 을 journal /Logs 또는 OSD 데이터로 설정합니다. NVMe 또는 기존 SATA/SAS 인터페이스를 사용하는지 여부에 관계없이 Solid State Drives(SSD)가 있는 경우 실제 데이터가 하드 디스크 드라이브(HDD)로 전환되거나 저널, 로그, 데이터에 대해 SSD를 사용할 수 있고 모든 Ceph OSD 기능에 대해 SSD를 사용할 수 있지만 NVMe/SAS 인터페이스를 사용할 수 있습니다.

Encryption 을 None 또는 Encrypted 로 설정합니다. LUKS1 형식을 사용하여 스토리지 장치의 미사용 암호화를 나타냅니다.

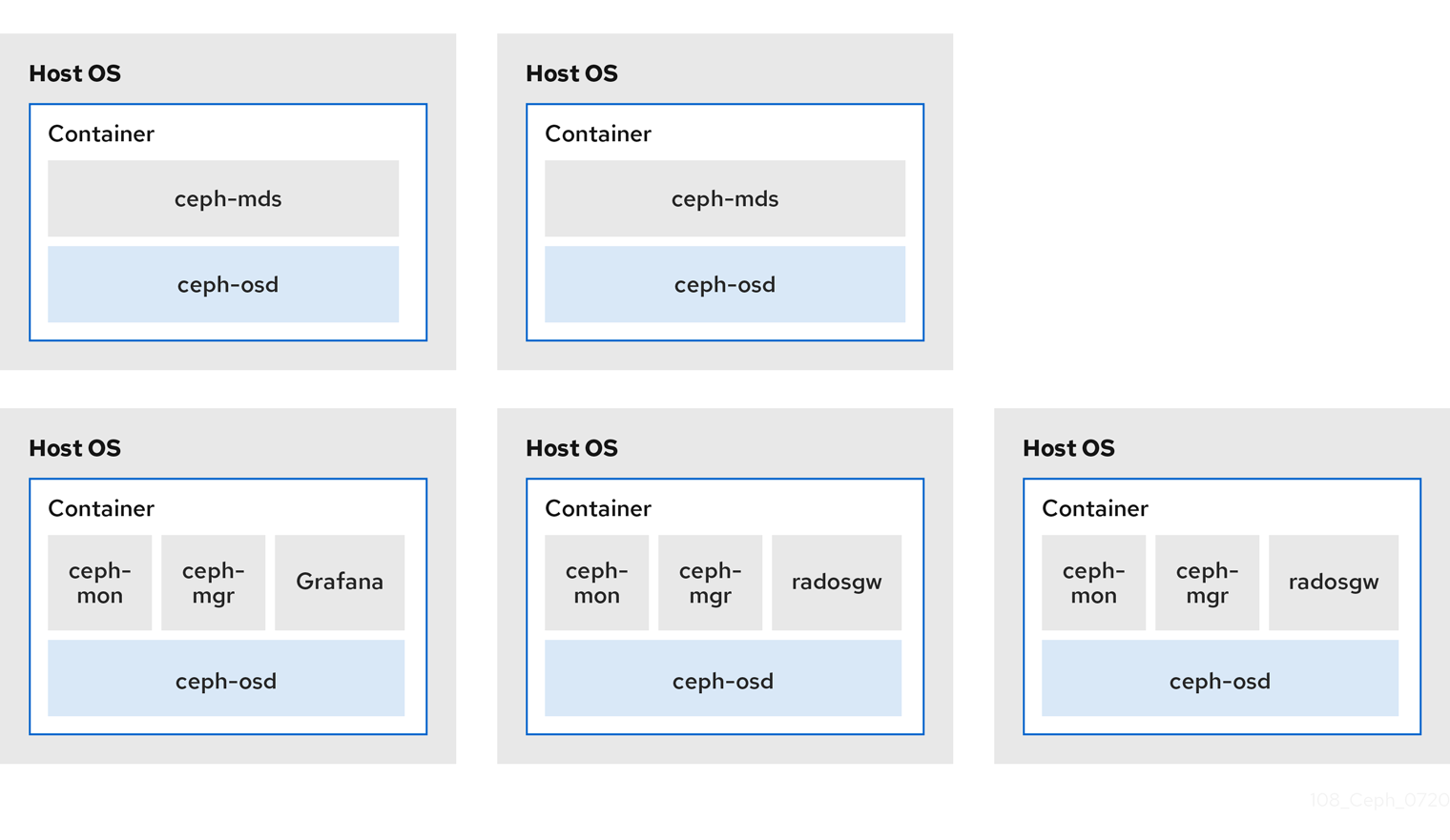

설치 유형을 Container 또는 RPM 으로 설정합니다. 일반적으로 Red Hat Package Manager(RPM)는 Red Hat Enterprise Linux에 소프트웨어를 설치하는 데 사용되었습니다. 이제 RPM 또는 컨테이너를 사용하여 Ceph를 설치할 수 있습니다. 컨테이너를 사용하여 Ceph를 설치하면 서비스를 분리하고 공동 배치할 수 있으므로 개선된 하드웨어 사용률을 제공할 수 있습니다.

모든 환경 설정을 검토하고 웹 페이지의 오른쪽 하단에 있는 Hosts (호스트) 버튼을 클릭합니다.

4.7. Cockpit Ceph 설치 프로그램의 Hosts 페이지 완료

Hosts (호스트) 페이지를 사용하면 Cockpit Ceph 설치 프로그램에 Ceph를 설치할 호스트와 각 호스트가 사용할 역할을 알릴 수 있습니다. 호스트를 추가하면 설치 프로그램에서 SSH 및 DNS 연결을 확인합니다.

사전 요구 사항

- Cockpit Ceph 설치 프로그램의 환경 페이지가 완료되었습니다.

- Cockpit Ceph Installer SSH 키가 클러스터의 모든 노드에 복사 되었습니다.

절차

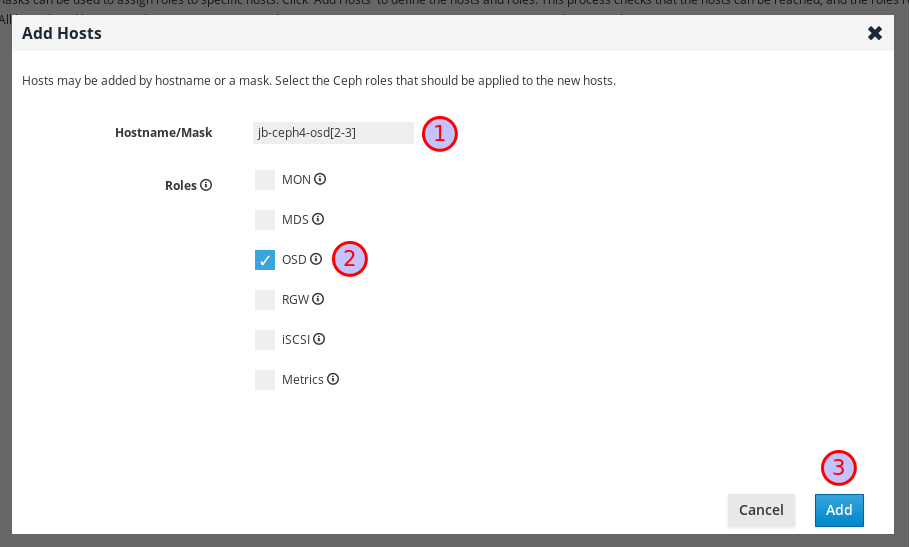

Add Host(s) (호스트 추가) 버튼을 클릭합니다.

Ceph OSD 노드의 호스트 이름을 입력하고 OSD의 확인란을 선택한 다음 Add (추가) 버튼을 클릭합니다.

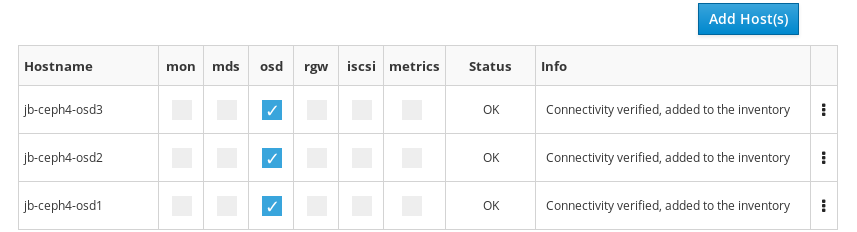

첫 번째 Ceph OSD 노드가 추가되었습니다.

프로덕션 클러스터의 경우 3개 이상의 Ceph OSD 노드를 추가할 때까지 이 단계를 반복합니다.

선택 사항: 호스트 이름 패턴을 사용하여 노드 범위를 정의합니다. 예를 들어

jb-ceph4-osd2및jb-ceph4-osd3을 동시에 추가하려면jb-ceph4-osd[2-3]을 입력합니다.

jb-ceph4-osd2및jb-ceph4-ods3이 추가되었습니다.

클러스터의 다른 노드에 대해 위의 단계를 반복합니다.

-

프로덕션 클러스터의 경우 3개 이상의 Ceph Monitor 노드를 추가합니다. 대화 상자에서는

MON으로 역할이 나열됩니다. -

Metrics역할이 있는 노드를 추가합니다.Metrics역할은 Grafana 및 Prometheus를 설치하여 Ceph 클러스터의 성능에 대한 실시간 정보를 제공합니다. 이러한 지표는 Ceph 대시보드에 제공되어 클러스터를 모니터링하고 관리할 수 있습니다. 대시보드, Grafana 및 Prometheus를 설치해야 합니다. Ansible 관리 노드에서 지표 기능을 배치할 수 있습니다. 이 경우 노드의 시스템 리소스가 독립형 메트릭 노드에 필요한 것보다 큰지 확인하십시오. -

선택 사항:

MDS역할이 있는 노드를 추가합니다.MDS역할은 Ceph 메타데이터 서버(MDS)를 설치합니다. 메타데이터 서버 데몬은 Ceph 파일 시스템을 배포하는 데 필요합니다. -

선택 사항:

RGW역할이 있는 노드를 추가합니다.RGW역할은 Ceph 개체 게이트웨이를 설치하고 RADOS 게이트웨이라고도 하며, RADOS 게이트웨이는 Ceph 스토리지 클러스터에 RESTful 게이트웨이를 제공하기 위해 librados API 상단에 구축된 오브젝트 스토리지 인터페이스입니다. Amazon S3 및 OpenStack Swift API를 지원합니다. -

선택 사항:

iSCSI역할로 노드를 추가합니다.iSCSI역할은 iSCSI 게이트웨이를 설치하므로 iSCSI를 통해 Ceph 블록 장치를 공유할 수 있습니다. Ceph에서 iSCSI를 사용하려면 다중 경로 I/O의 두 개 이상의 노드에 iSCSI 게이트웨이를 설치해야 합니다.

-

프로덕션 클러스터의 경우 3개 이상의 Ceph Monitor 노드를 추가합니다. 대화 상자에서는

선택 사항: 노드를 추가할 때 여러 역할을 선택하여 동일한 노드에서 두 개 이상의 서비스를 연결합니다.

데몬 배치에 대한 자세한 내용은 설치 가이드의 컨테이너화된 Ceph 데몬 배치를 참조하십시오.

선택 사항: 표에서 역할을 확인하거나 선택 해제하여 노드에 할당된 역할을 수정합니다.

선택 사항: 노드를 삭제하려면 삭제할 노드 행의 맨 오른쪽에 있는 kebab 아이콘을 클릭한 다음 삭제 를 클릭합니다.

클러스터의 모든 노드를 추가하고 필요한 모든 역할을 설정한 후 페이지의 오른쪽 아래에 있는 Validate 버튼을 클릭합니다.

프로덕션 클러스터의 경우 3개 또는 5개의 모니터를 사용하지 않는 한 Cockpit Ceph 설치 프로그램이 진행되지 않습니다. 이 예제에서 Cluster Type 은 Development/POC 로 설정되어 하나의 모니터만으로 설치가 진행될 수 있습니다.

4.8. Cockpit Ceph 설치 프로그램의 검증 페이지 완료

Validate (유효성 검사) 페이지를 사용하면 Hosts (호스트) 페이지에서 제공한 노드를 검색하여 해당 노드를 사용할 역할의 하드웨어 요구 사항을 충족하는지 확인할 수 있습니다.

사전 요구 사항

- Cockpit Ceph 설치 프로그램의 Hosts 페이지가 완료되었습니다.

절차

프로브 호스트 버튼을 클릭합니다.

계속하려면 OK Status 가 있는 호스트를 3개 이상 선택해야 합니다.

선택 사항: 호스트에 대한 경고 또는 오류가 생성된 경우 호스트에 대한 확인 표시 왼쪽에 있는 화살표를 클릭하여 문제를 확인합니다.

중요

중요Cluster Type 을 Production 으로 설정하면 생성된 모든 오류로 인해 상태가 NOTOK 로 되어 설치 시 해당 상태를 선택할 수 없습니다. 오류 해결 방법에 대한 자세한 내용은 다음 단계를 참조하십시오.

중요Cluster Type 을 Development/POC 로 설정하면 생성된 모든 오류가 경고로 나열되므로 상태가 항상 OK 입니다. 이를 통해 호스트가 요구 사항 또는 제안 사항을 충족하는지 여부와 관계없이 호스트를 선택하고 Ceph를 설치할 수 있습니다. 원하는 경우 경고를 계속 해결할 수 있습니다. 경고를 해결하는 방법에 대한 자세한 내용은 다음 단계를 참조하십시오.

선택 사항: 오류 및 경고를 해결하려면 다음 방법 중 하나 이상을 사용합니다.

오류 또는 경고를 해결하는 가장 쉬운 방법은 특정 역할을 완전히 비활성화하거나 한 호스트에서 역할을 비활성화하고 필요한 리소스가 있는 다른 호스트에서 활성화하는 것입니다.

개발/POC 클러스터를 설치하는 경우 또는 프로덕션 클러스터를 설치하는 경우, 3개 이상의 호스트에 할당된 역할에 필요한 모든 리소스가 있으므로 나머지 경고를 찾을 때까지 역할을 활성화 또는 비활성화하기 전에 역할을 활성화하거나 비활성화할 수 있습니다.

필요한 역할에 대한 요구 사항을 충족하는 새 호스트를 사용할 수도 있습니다. 먼저 Hosts (호스트) 페이지로 돌아가 문제가 있는 호스트를 삭제합니다.

그런 다음 새 호스트를 추가합니다.

- 호스트에서 하드웨어를 업그레이드하거나 다른 방식으로 수정하려면 요구 사항 또는 제안을 충족하고 먼저 호스트를 원하는 대로 변경한 다음 프로브 호스트를 다시 클릭합니다. 운영 체제를 다시 설치해야 하는 경우 SSH 키를 다시 복사 해야 합니다.

호스트 옆에 있는 상자를 선택하여 Red Hat Ceph Storage를 설치할 호스트를 선택합니다.

중요

중요프로덕션 클러스터를 설치하는 경우 설치용으로 선택하기 전에 오류를 해결해야 합니다.

페이지의 오른쪽 아래에 있는 네트워크 버튼을 클릭하여 클러스터의 네트워킹을 검토 및 구성합니다.

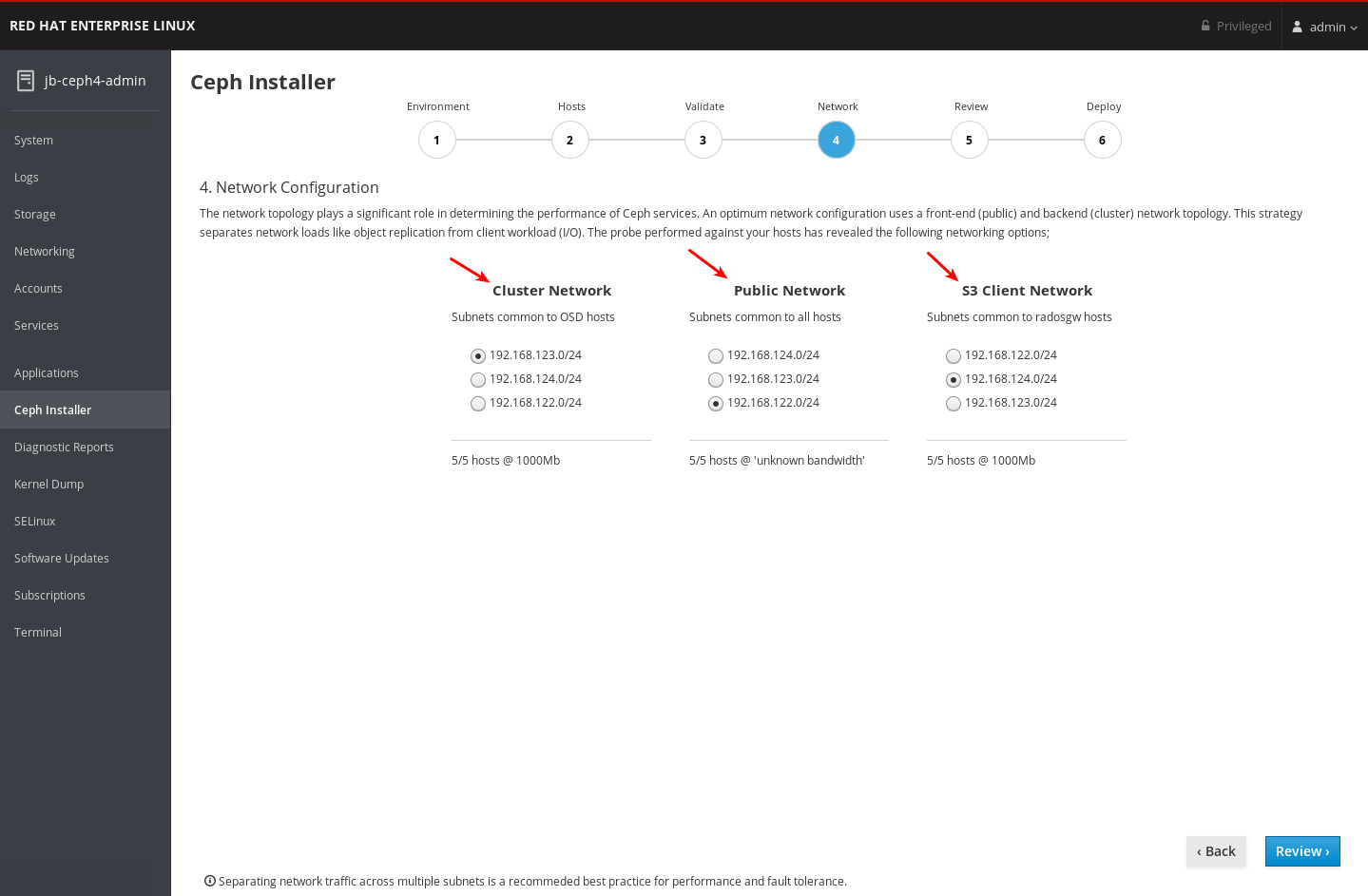

4.9. Cockpit Ceph 설치 프로그램의 네트워크 페이지 완료

네트워크 페이지를 사용하면 특정 클러스터 통신 유형을 특정 네트워크에 분리할 수 있습니다. 이를 위해서는 클러스터의 호스트 전체에 구성된 여러 다른 네트워크가 필요합니다.

네트워크 페이지는 Validate 페이지에서 수행한 프로브에서 수집된 정보를 사용하여 호스트에서 액세스할 수 있는 네트워크를 표시합니다. 현재 네트워크 페이지를 이미 진행한 경우 호스트에 새 네트워크를 추가하고, Validate (유효성 검사) 페이지로 돌아가 호스트를 재프로필하고, 네트워크 페이지로 다시 이동하여 새 네트워크를 사용할 수 없습니다. 선택시 표시되지 않습니다. 네트워크 페이지로 이동한 후 호스트에 추가된 네트워크를 사용하려면 웹 페이지를 완전히 새로 고침한 후 처음부터 설치를 다시 시작해야 합니다.

프로덕션 클러스터의 경우 별도의 NIC에서 클라이언트 간 트래픽과 클러스터 내 트래픽을 분리해야 합니다. 클러스터 트래픽 유형을 분리하는 것 외에도 Ceph 클러스터를 설정할 때 고려해야 할 다른 네트워킹 고려 사항이 있습니다. 자세한 내용은 하드웨어 가이드의 네트워크 고려 사항을 참조하십시오.

사전 요구 사항

- Cockpit Ceph 설치 프로그램의 검증 페이지가 완료되었습니다.

절차

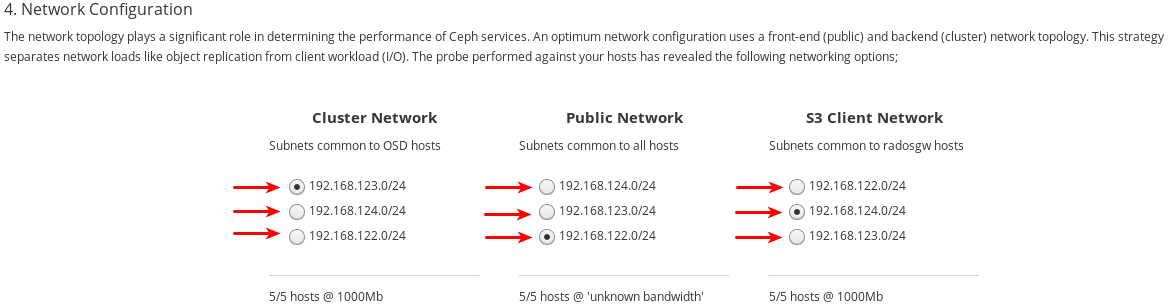

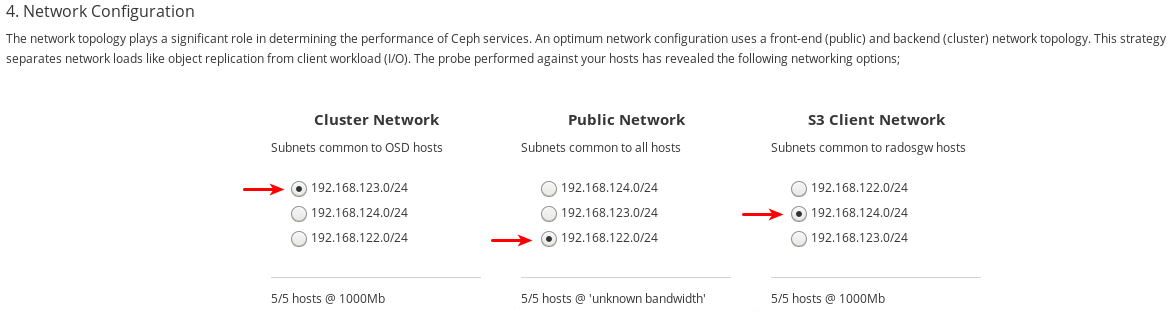

네트워크 페이지에서 구성할 수 있는 네트워크 유형을 기록해 두십시오. 각 유형에는 자체 열이 있습니다. 클러스터 네트워크 및 공용 네트워크 의 열이 항상 표시됩니다. RADOS Gateway 역할을 사용하여 호스트를 설치하는 경우 S3 네트워크 열이 표시됩니다. iSCSI 역할로 호스트를 설치하는 경우 iSCSI 네트워크 열이 표시됩니다. 아래 예에서는 Cluster Network,Public Network, S3 Network 에 대한 열이 표시됩니다.

각 네트워크 유형에 대해 선택할 수 있는 네트워크를 기록해 두십시오. 특정 네트워크 유형을 구성하는 모든 호스트에서 사용 가능한 네트워크만 표시됩니다. 아래 예제에는 클러스터의 모든 호스트에서 사용할 수 있는 세 개의 네트워크가 있습니다. 네트워크 유형을 구성하는 모든 호스트에서 세 개의 네트워크를 모두 사용할 수 있으므로 각 네트워크 유형은 동일한 세 개의 네트워크를 나열합니다.

사용 가능한 세 개의 네트워크는

192.168.122.0/24,192.168.123.0/24,192.168.124.0/24입니다.각 네트워크가 작동하는 속도를 기록해 두십시오. 이는 특정 네트워크에 사용되는 NIC의 속도입니다. 아래 예에서

192.168.123.0/24및192.168.124.0/24는 1,000mbps입니다. Cockpit Ceph 설치 프로그램에서192.168.122.0/24네트워크의 속도를 확인할 수 없습니다.

각 네트워크 유형에 사용할 네트워크를 선택합니다. 프로덕션 클러스터의 경우 클러스터 네트워크 및 공용 네트워크에 대해 별도 의 네트워크를 선택해야 합니다. 개발/POC 클러스터의 경우 두 유형 모두에 대해 동일한 네트워크를 선택하거나 모든 호스트에 하나의 네트워크만 구성되어 있는 경우 해당 네트워크만 표시되고 다른 네트워크를 선택할 수 없습니다.

192.168.122.0/24네트워크는 공용 네트워크에 사용되며192.168.123.0/24네트워크는 클러스터 네트워크 용으로 사용되며192.168.124.0/24네트워크는 S3 네트워크에 사용됩니다.페이지 오른쪽 하단의 검토 버튼을 클릭하여 설치 전에 전체 클러스터 구성을 검토합니다.

4.10. 설치 구성 검토

검토 페이지를 통해 이전 페이지에 설정한 Ceph 클러스터 설치 구성의 모든 세부 정보와 이전 페이지에 포함되지 않은 호스트에 대한 세부 정보를 볼 수 있습니다.

사전 요구 사항

- Cockpit Ceph 설치 프로그램의 네트워크 페이지가 완료되었습니다.

절차

검토 페이지를 봅니다.

검토 페이지에 표시된 대로 이전 페이지의 정보가 예상과 같은지 확인합니다. 환경 페이지의 정보 요약은 1 에 있는 호스트 페이지 2 에서 호스트 페이지, 3 에서 네트워크 페이지, 4 에서 네트워크 페이지 및 이전 페이지에 포함되지 않은 몇 가지 추가 세부 정보를 포함하여 호스트에 대한 세부 정보는 5 입니다.

페이지의 오른쪽 하단 모서리에 있는 Deploy (배포) 버튼을 클릭하여 Deploy (배포) 페이지로 이동하여 실제 설치 프로세스를 종료하고 시작할 수 있습니다.

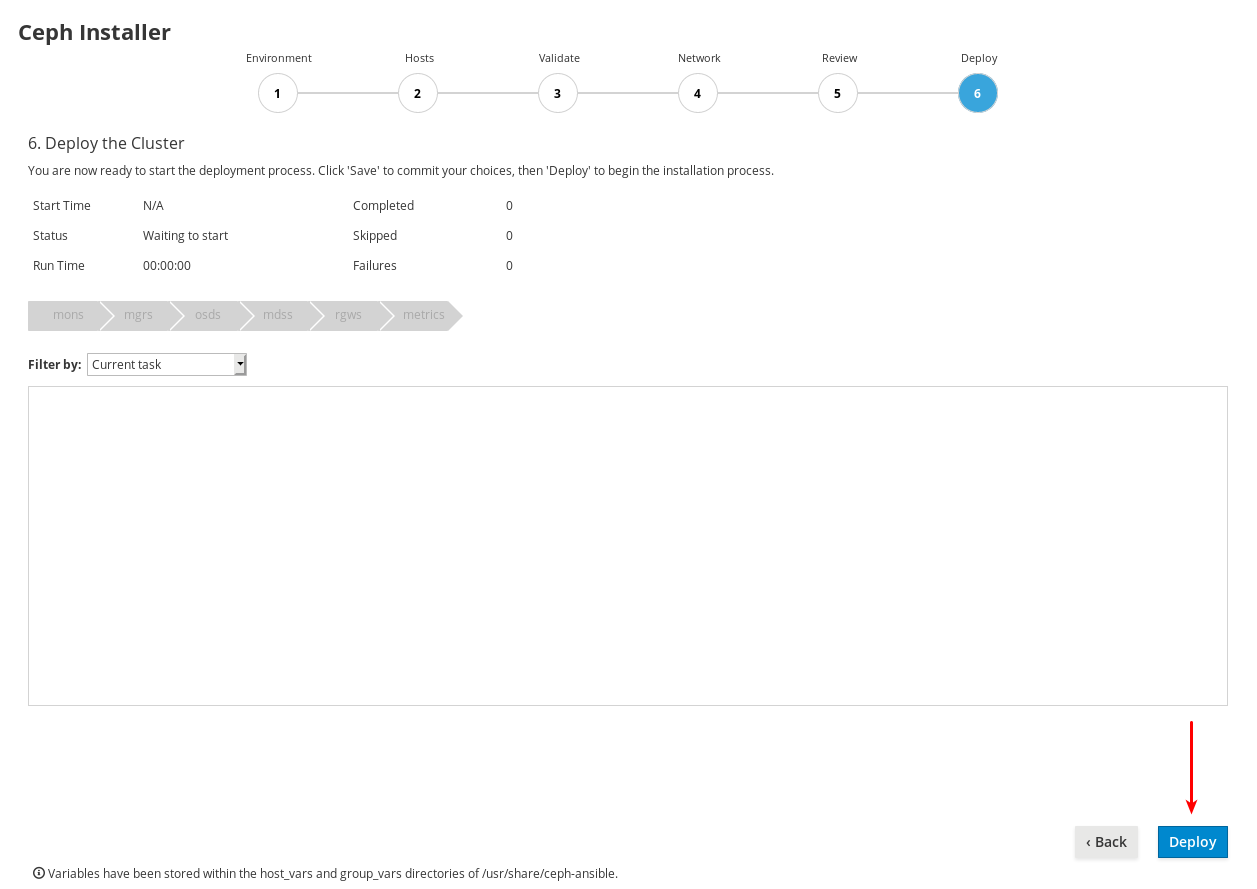

4.11. Ceph 클러스터 배포

배포 페이지를 사용하면 설치 설정을 네이티브 Ansible 형식으로 저장하고, 필요한 경우 이를 검토하거나 수정하고, 설치를 시작하고, 진행 상황을 모니터링하며, 설치가 완료된 후 클러스터 상태를 볼 수 있습니다.

사전 요구 사항

- 검토 페이지 의 설치 구성 설정이 확인되었습니다.

절차

페이지의 오른쪽 아래에 있는 Save 버튼을 클릭하여 Ansible에서 실제 설치를 수행하는 데 사용할 Ansible 플레이북에 설치 설정을 저장합니다.

-

선택 사항: Ansible 관리 노드에 있는 Ansible 플레이북의 설정을 확인하거나 추가로 사용자 지정합니다. 플레이북은

/usr/share/ceph-ansible에 있습니다. Ansible 플레이북과 설치를 사용자 지정하는 방법에 대한 자세한 내용은 Red Hat Ceph Storage 클러스터 설치를 참조하십시오. -

Grafana 및 대시보드의 기본 사용자 이름 및 암호를 보호합니다. Red Hat Ceph Storage 4.1부터

/usr/share/ceph-ansible/group_vars/all.yml에서dashboard_admin_password및grafana_admin_password의 주석 처리를 해제하거나 설정해야 합니다. 각각에 대해 보안 암호를 설정합니다.dashboard_admin_user및grafana_admin_user의 사용자 지정 사용자 이름도 설정합니다. 페이지의 오른쪽 하단 모서리에 있는 Deploy (배포) 버튼을 클릭하여 설치를 시작합니다.

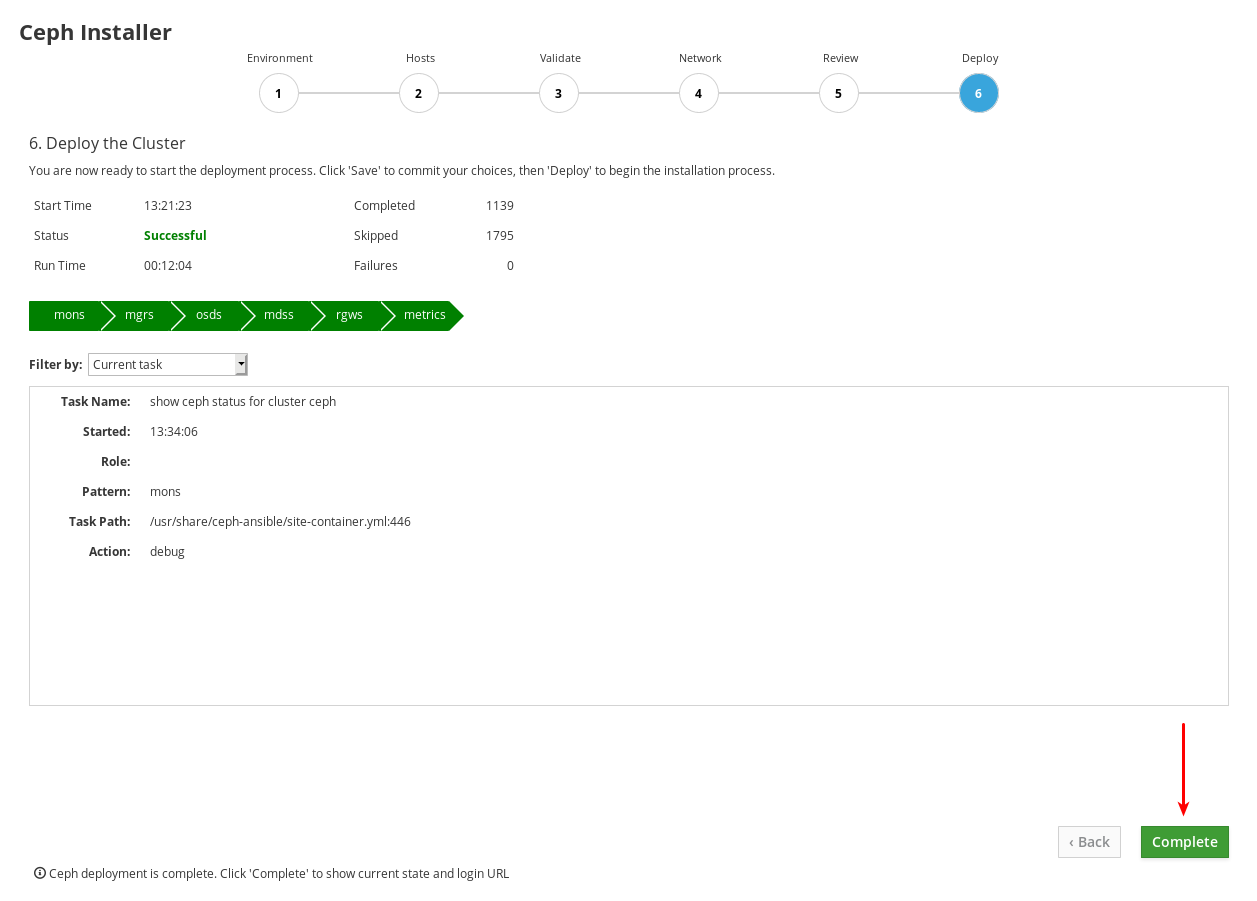

실행 중인 동안 설치 진행 상황을 관찰합니다.

1 의 정보는 설치가 실행 중인지, 시작 시간, 경과된 시간입니다. 2 의 정보는 시도된 Ansible 작업의 요약을 보여줍니다. 3 의 정보는 설치 또는 설치 중인 역할을 보여줍니다. 녹색은 해당 역할에 할당된 모든 호스트가 해당 역할에 설치된 역할을 나타냅니다. Blue는 해당 역할이 할당된 호스트가 여전히 설치되어 있는 역할을 나타냅니다. 4 에서 현재 작업에 대한 세부 정보를 보거나 실패한 작업을 볼 수 있습니다. 필터 기준 메뉴를 사용하여 현재 작업과 실패한 작업 간에 전환합니다.

역할 이름은 Ansible 인벤토리 파일에서 가져옵니다. 동등성:

mons는 Monitors이고,mgrs는 Managers이고, Manager 역할은 Monitor 역할과 함께 설치되고,osds는 Object Storage Devices이고,mdss는 Metadata Servers이고,rgws는 RADOS Gateways이고,지표는 Grafana 및 Prometheus 서비스 대시보드입니다. 예제 스크린샷에는 표시되지 않습니다.iscsigws는 iSCSI 게이트웨이입니다.설치가 완료되면 페이지의 오른쪽 아래에 있는 완료 버튼을 클릭합니다. 그러면 명령

ceph 상태및 대시보드 액세스 정보의 출력이 표시되는 창이 열립니다.

아래 예에서 클러스터 상태 정보를 클러스터의 클러스터 상태 정보와 비교합니다. 이 예에서는 모든 OSD up 및 in 및 모든 서비스가 활성 상태인 정상 클러스터를 보여줍니다. PGS는

active+clean상태입니다. 클러스터의 일부 측면이 동일하지 않은 경우 문제 해결 방법에 대한 자세한 내용은 Troubleshoting Guide 를 참조하십시오.

Ceph Cluster Status(Ceph 클러스터 상태) 창의 맨 아래에 URL, 사용자 이름, 암호 등 대시보드 액세스 정보가 표시됩니다. 이 정보를 기록해 두십시오.

대시보드 가이드와 함께 이전 단계의 정보를 사용하여 대시보드에 액세스 합니다.

대시보드는 웹 인터페이스를 제공하므로 Red Hat Ceph Storage 클러스터를 관리하고 모니터링할 수 있습니다. 자세한 내용은 대시보드 가이드 를 참조하십시오.

-

선택 사항:

cockpit-ceph-installer.log파일을 봅니다. 이 파일은 선택한 로그와 프로브 프로세스가 생성된 경고를 기록합니다. 설치 프로그램 스크립트ansible-runner-service.sh를 실행한 사용자의 홈 디렉터리에 있습니다.

5장. Ansible을 사용하여 Red Hat Ceph Storage 설치

이 장에서는 Ansible 애플리케이션을 사용하여 Red Hat Ceph Storage 클러스터 및 메타데이터 서버 또는 Ceph Object Gateway와 같은 기타 구성 요소를 배포하는 방법을 설명합니다.

- Red Hat Ceph Storage 클러스터를 설치하려면 5.2절. “Red Hat Ceph Storage 클러스터 설치” 에서 참조하십시오.

- 메타데이터 서버를 설치하려면 5.4절. “메타데이터 서버 설치” 에서 참조하십시오.

-

ceph-client역할을 설치하려면 5.5절. “Ceph 클라이언트 역할 설치” 에서 참조하십시오. - Ceph Object Gateway를 설치하려면 5.6절. “Ceph Object Gateway 설치” 에서 참조하십시오.

- 다중 사이트 Ceph 오브젝트 게이트웨이를 구성하려면 5.7절. “다중 사이트 Ceph 개체 게이트웨이 구성” 을 참조하십시오.

-

Ansible

--limit옵션에 대한 자세한 내용은 5.10절. “제한옵션 이해” 을 참조하십시오.

5.1. 사전 요구 사항

- 유효한 고객 서브스크립션을 받으십시오.

각 노드에서 다음을 수행하여 클러스터 노드를 준비합니다.

5.2. Red Hat Ceph Storage 클러스터 설치

ceph-ansible 플레이북과 함께 Ansible 애플리케이션을 사용하여 베어 메탈 또는 컨테이너에 Red Hat Ceph Storage를 설치합니다. 프로덕션 환경에서 Ceph 스토리지 클러스터를 사용하려면 최소 3개의 모니터 노드와 여러 OSD 데몬이 포함된 OSD 노드 3개가 있어야 합니다. 프로덕션 환경에서 실행되는 일반적인 Ceph 스토리지 클러스터는 일반적으로 10개 이상의 노드로 구성됩니다.

다음 절차에서는 달리 지침이 없는 경우 Ansible 관리 노드에서 명령을 실행합니다. 이 절차는 지정하지 않는 한 베어 메탈 및 컨테이너 배포에 모두 적용됩니다.

Ceph는 하나의 모니터로 실행할 수 있지만 프로덕션 클러스터에서 고가용성을 보장하기 위해 Red Hat은 모니터 노드가 세 개 이상인 배포만 지원합니다.

Red Hat Enterprise Linux 7.7의 컨테이너에 Red Hat Ceph Storage 4를 배포하면 Red Hat Enterprise Linux 8 컨테이너 이미지에 Red Hat Ceph Storage 4가 배포됩니다.

사전 요구 사항

- 유효한 고객 서브스크립션.

- Ansible 관리 노드에 대한 루트 수준 액세스.

-

Ansible 애플리케이션과 함께 사용할

ansible사용자 계정입니다. - Red Hat Ceph Storage Tools 및 Ansible 리포지토리 활성화

- ISO 설치의 경우 Ansible 노드에 최신 ISO 이미지를 다운로드합니다. Red Hat Ceph Storage 설치 가이드 의 Red Hat Ceph Storage 리포지토리 활성화 장을 참조하십시오.

절차

-

Ansible 관리 노드에

root사용자 계정으로 로그인합니다. 모든 배포가 베어 메탈 또는 컨테이너 의 경우

ceph-ansible패키지를 설치합니다.Red Hat Enterprise Linux 7

[root@admin ~]# yum install ceph-ansible

Red Hat Enterprise Linux 8

[root@admin ~]# dnf install ceph-ansible

/usr/share/ceph-ansible/디렉토리로 이동합니다.[root@admin ~]# cd /usr/share/ceph-ansible

새

yml파일을 생성합니다.[root@admin ceph-ansible]# cp group_vars/all.yml.sample group_vars/all.yml [root@admin ceph-ansible]# cp group_vars/osds.yml.sample group_vars/osds.yml

베어 메탈 배포:

[root@admin ceph-ansible]# cp site.yml.sample site.yml

컨테이너 배포:

[root@admin ceph-ansible]# cp site-container.yml.sample site-container.yml

새 파일을 편집합니다.

group_vars/all.yml파일을 편집하려면 을 엽니다.중요사용자 정의 스토리지 클러스터 이름 사용은 지원되지 않습니다.

클러스터매개변수를ceph이외의 값으로 설정하지 마십시오. 사용자 지정 스토리지 클러스터 이름 사용은librados, Ceph Object Gateway 및 RADOS 블록 장치 미러링과 같은 Ceph 클라이언트에서만 지원됩니다.주의기본적으로 Ansible은 설치된

firewalld서비스를 다시 시작하려고 하지만 마스킹되어 Red Hat Ceph Storage 배포가 실패할 수 있습니다. 이 문제를 해결하려면all.yml파일에서configure_firewall옵션을false로 설정합니다.firewalld서비스를 실행하는 경우all.yml파일에서configure_firewall옵션을 사용할 필요가 없습니다.참고ceph_rhcs_version옵션을4로 설정하면 최신 버전의 Red Hat Ceph Storage 4가 가져옵니다.참고Red Hat은

group_vars/all.yml파일에서dashboard_enabled옵션을True로 설정하고False로 변경하지 않는 것이 좋습니다. 대시보드를 비활성화하려면 Ceph 대시보드 비활성화를 참조하십시오.참고대시보드 관련 구성 요소는 컨테이너화되어 있습니다. 따라서 베어 메탈 또는 컨테이너 배포의 경우

ceph_docker_registry_username및ceph_docker_registry_password매개변수를 포함해야 ceph-ansible이 대시보드에 필요한 컨테이너 이미지를 가져올 수 있습니다.참고Red Hat Registry Service 계정이 없는 경우 레지스트리 서비스 계정 웹 페이지를 사용하여 생성합니다. 토큰을 만들고 관리하는 방법에 대한 자세한 내용은 Red Hat Container Registry Authentication Knowledgebase 문서를 참조하십시오.

참고ceph_docker_registry_username및ceph_docker_registry_password매개변수에 서비스 계정을 사용하는 것 외에도 고객 포털 자격 증명을 사용하지만 보안을 보장하기 위해ceph_docker_registry_password매개변수를 암호화할 수 있습니다. 자세한 내용은 ansible-vault를 사용하여 Ansible 암호 변수 암호화 를 참조하십시오.CDN 설치를 위한

all.yml파일의 베어 메탈 예:fetch_directory: ~/ceph-ansible-keys ceph_origin: repository ceph_repository: rhcs ceph_repository_type: cdn ceph_rhcs_version: 4 monitor_interface: eth0 1 public_network: 192.168.0.0/24 ceph_docker_registry: registry.redhat.io ceph_docker_registry_auth: true ceph_docker_registry_username: SERVICE_ACCOUNT_USER_NAME ceph_docker_registry_password: TOKEN dashboard_admin_user: dashboard_admin_password: node_exporter_container_image: registry.redhat.io/openshift4/ose-prometheus-node-exporter:v4.6 grafana_admin_user: grafana_admin_password: grafana_container_image: registry.redhat.io/rhceph/rhceph-4-dashboard-rhel8 prometheus_container_image: registry.redhat.io/openshift4/ose-prometheus:v4.6 alertmanager_container_image: registry.redhat.io/openshift4/ose-prometheus-alertmanager:v4.6

- 1

- 공용 네트워크의 인터페이스입니다.

중요Red Hat Ceph Storage 4.1부터

/usr/share/ceph-ansible/group_vars/all.yml에서dashboard_admin_password및grafana_admin_password의 주석 처리를 해제하거나 설정해야 합니다. 각각에 대해 보안 암호를 설정합니다.dashboard_admin_user및grafana_admin_user의 사용자 지정 사용자 이름도 설정합니다.참고Red Hat Ceph Storage 4.2의 경우 설치를 위해 로컬 레지스트리를 사용한 경우 Prometheus 이미지 태그에 4.6을 사용합니다.

ISO 설치를 위한

all.yml파일의 베어 메탈 예:fetch_directory: ~/ceph-ansible-keys ceph_origin: repository ceph_repository: rhcs ceph_repository_type: iso ceph_rhcs_iso_path: /home/rhceph-4-rhel-8-x86_64.iso ceph_rhcs_version: 4 monitor_interface: eth0 1 public_network: 192.168.0.0/24 ceph_docker_registry: registry.redhat.io ceph_docker_registry_auth: true ceph_docker_registry_username: SERVICE_ACCOUNT_USER_NAME ceph_docker_registry_password: TOKEN dashboard_admin_user: dashboard_admin_password: node_exporter_container_image: registry.redhat.io/openshift4/ose-prometheus-node-exporter:v4.6 grafana_admin_user: grafana_admin_password: grafana_container_image: registry.redhat.io/rhceph/rhceph-4-dashboard-rhel8 prometheus_container_image: registry.redhat.io/openshift4/ose-prometheus:v4.6 alertmanager_container_image: registry.redhat.io/openshift4/ose-prometheus-alertmanager:v4.6

- 1

- 공용 네트워크의 인터페이스입니다.

all.yml파일의 컨테이너 예:fetch_directory: ~/ceph-ansible-keys monitor_interface: eth0 1 public_network: 192.168.0.0/24 ceph_docker_image: rhceph/rhceph-4-rhel8 ceph_docker_image_tag: latest containerized_deployment: true ceph_docker_registry: registry.redhat.io ceph_docker_registry_auth: true ceph_docker_registry_username: SERVICE_ACCOUNT_USER_NAME ceph_docker_registry_password: TOKEN ceph_origin: repository ceph_repository: rhcs ceph_repository_type: cdn ceph_rhcs_version: 4 dashboard_admin_user: dashboard_admin_password: node_exporter_container_image: registry.redhat.io/openshift4/ose-prometheus-node-exporter:v4.6 grafana_admin_user: grafana_admin_password: grafana_container_image: registry.redhat.io/rhceph/rhceph-4-dashboard-rhel8 prometheus_container_image: registry.redhat.io/openshift4/ose-prometheus:v4.6 alertmanager_container_image: registry.redhat.io/openshift4/ose-prometheus-alertmanager:v4.6

- 1

- 공용 네트워크의 인터페이스입니다.

중요Red Hat Ecosystem Catalog 에서 최신 컨테이너 이미지 태그를 조회하여 모든 최신 패치가 적용된 최신 컨테이너 이미지를 설치합니다.

all.yml파일의 컨테이너 예: Red Hat Ceph Storage 노드가 배포 중에 인터넷에 액세스할 수 없는 경우:fetch_directory: ~/ceph-ansible-keys monitor_interface: eth0 1 public_network: 192.168.0.0/24 ceph_docker_image: rhceph/rhceph-4-rhel8 ceph_docker_image_tag: latest containerized_deployment: true ceph_docker_registry: LOCAL_NODE_FQDN:5000 ceph_docker_registry_auth: false ceph_origin: repository ceph_repository: rhcs ceph_repository_type: cdn ceph_rhcs_version: 4 dashboard_admin_user: dashboard_admin_password: node_exporter_container_image: LOCAL_NODE_FQDN:5000/openshift4/ose-prometheus-node-exporter:v4.6 grafana_admin_user: grafana_admin_password: grafana_container_image: LOCAL_NODE_FQDN:5000/rhceph/rhceph-4-dashboard-rhel8 prometheus_container_image: LOCAL_NODE_FQDN:5000/openshift4/ose-prometheus:4.6 alertmanager_container_image: LOCAL_NODE_FQDN:5000/openshift4/ose-prometheus-alertmanager:4.6

- 1

- 공용 네트워크의 인터페이스입니다.

- 대체 버전

- 로컬 호스트 FQDN을 사용한 LOCAL_NODE_FQDN.

Red Hat Ceph Storage 4.2에서

dashboard_protocol은https로 설정되고 Ansible은 대시보드 및 grafana 키 및 인증서를 생성합니다. 사용자 정의 인증서의 경우all.yml파일에서dashboard_crt,dashboard_key, grafana_crt ,grafana_crt에 대한 Ansible 설치 프로그램 호스트의 경로를 업데이트합니다. 베어 메탈 또는 컨테이너 배포의 경우grafana_key입니다.구문

dashboard_protocol: https dashboard_port: 8443 dashboard_crt: 'DASHBOARD_CERTIFICATE_PATH' dashboard_key: 'DASHBOARD_KEY_PATH' dashboard_tls_external: false dashboard_grafana_api_no_ssl_verify: "{{ True if dashboard_protocol == 'https' and not grafana_crt and not grafana_key else False }}" grafana_crt: 'GRAFANA_CERTIFICATE_PATH' grafana_key: 'GRAFANA_KEY_PATH'

http 또는 https 프록시와 함께 연결할 수 있는 컨테이너 레지스트리를 사용하여 Red Hat Ceph Storage를 설치하려면

group_vars/all.yml파일에서ceph_docker_http_proxy또는ceph_docker_https_proxy변수를 설정합니다.예제

ceph_docker_http_proxy: http://192.168.42.100:8080 ceph_docker_https_proxy: https://192.168.42.100:8080

프록시 구성에 대해 일부 호스트를 제외해야 하는 경우

group_vars/all.yml파일의ceph_docker_no_proxy변수를 사용합니다.예제

ceph_docker_no_proxy: "localhost,127.0.0.1"

Red Hat Ceph Storage 프록시 설치를 위해

all.yml파일을 편집하는 것 외에도/etc/environment파일을 편집합니다.예제

HTTP_PROXY: http://192.168.42.100:8080 HTTPS_PROXY: https://192.168.42.100:8080 NO_PROXY: "localhost,127.0.0.1"

그러면 podman을 트리거하여 prometheus, grafana-server, alertmanager, node-exporter와 같은 컨테이너화된 서비스를 시작하고 필요한 이미지를 다운로드합니다.

모든 배포의 경우 베어 메탈 또는 컨테이너에 대해

group_vars/osds.yml파일을 편집합니다.중요운영 체제가 설치된 장치에 OSD를 설치하지 마십시오. 운영 체제와 OSD 간에 동일한 장치를 공유하면 성능 문제가 발생합니다.

Ceph-ansible은

ceph-volume툴을 사용하여 Ceph 사용을 위해 스토리지 장치를 준비합니다. 다양한 방법으로 스토리지 장치를 사용하여 특정 워크로드에 대한 성능을 최적화하도록osds.yml을 구성할 수 있습니다.중요아래 모든 예제에서는 Ceph 형식에서 장치의 데이터를 저장하는 데 사용하는 BlueStore 오브젝트 저장소를 사용합니다. 이전에는 Ceph에서 FileStore를 오브젝트 저장소로 사용했습니다. BlueStore는 더 많은 기능과 향상된 성능을 제공하기 때문에 이 형식은 새로운 Red Hat Ceph Storage 4.0 설치에서 더 이상 사용되지 않습니다. FileStore를 계속 사용할 수는 있지만 이를 사용하려면 Red Hat 지원 예외가 필요합니다. BlueStore에 대한 자세한 내용은 Red Hat Ceph Storage 아키텍처 가이드의 Ceph BlueStore 를 참조하십시오.

자동 검색

osd_auto_discovery: true

위 예제에서는 시스템의 빈 스토리지 장치를 모두 사용하여 OSD를 생성하므로 명시적으로 지정할 필요가 없습니다.

ceph-volume툴에서는 빈 장치를 확인하므로 비어 있지 않은 장치는 사용되지 않습니다.참고나중에

purge-docker-cluster.yml또는purge-cluster.yml을 사용하여 클러스터를 제거하도록 결정하는 경우osd_auto_discovery를 주석 처리하고osds.yml파일에 OSD 장치를 선언해야 합니다. 자세한 내용은 Ansible에서 배포한 스토리지 클러스터 삭제를 참조하십시오.간단한 설정

첫 번째 시나리오

devices: - /dev/sda - /dev/sdb

또는

두 번째 시나리오

devices: - /dev/sda - /dev/sdb - /dev/nvme0n1 - /dev/sdc - /dev/sdd - /dev/nvme1n1

또는

세 번째 시나리오

lvm_volumes: - data: /dev/sdb - data: /dev/sdc

또는

네 번째 시나리오

lvm_volumes: - data: /dev/sdb - data:/dev/nvme0n1devices옵션을 단독으로 사용하는 경우ceph-volume lvm 배치모드에서 OSD 구성을 자동으로 최적화합니다.첫 번째 시나리오에서는

장치가기존 하드 드라이브 또는 SSD인 경우 장치당 하나의 OSD가 생성됩니다.두 번째 시나리오에서는 기존 하드 드라이브와 SSD가 혼합된 경우 데이터는 기존 하드 드라이브(

sda,sdb)에 배치되고 BlueStore 데이터베이스는 SSD(nvme0n1)에서 최대한 크게 생성됩니다. 마찬가지로 데이터는 기존의 하드 드라이브(sdc,sdd)에 배치되고, BlueStore 데이터베이스는 언급된 장치 순서에 관계없이 SSDnvme1n1에 생성됩니다.참고기본적으로

ceph-ansible은bluestore_block_db_size및bluestore_block_wal_size의 기본값을 재정의하지 않습니다.group_vars/all.yml파일에서ceph_conf_overrides를 사용하여bluestore_block_db_size를 설정할 수 있습니다.bluestore_block_db_size값은 2GB보다 커야 합니다.세 번째 시나리오에서는 데이터가 기존 하드 드라이브(

sdb,sdc)에 배치되고 BlueStore 데이터베이스는 동일한 장치에 배치됩니다.네 번째 시나리오에서는 데이터가 기존 하드 드라이브(

sdb) 및 SSD(nvme1n1)에 배치되고 BlueStore 데이터베이스가 동일한 장치에 배치됩니다. 이는 BlueStore 데이터베이스가 SSD에 배치된devices지시문을 사용하는 것과 다릅니다.중요ceph-volume lvm 배치 모드명령은 기존 하드 드라이브와 BlueStore 데이터베이스에 데이터를 SSD에 배치하여 최적화된 OSD 구성을 생성합니다. 사용할 논리 볼륨 및 볼륨 그룹을 지정하려면 아래 고급 구성 시나리오를 따라 직접 생성할 수 있습니다.고급 설정

첫 번째 시나리오

devices: - /dev/sda - /dev/sdb dedicated_devices: - /dev/sdx - /dev/sdy

또는

두 번째 시나리오

devices: - /dev/sda - /dev/sdb dedicated_devices: - /dev/sdx - /dev/sdy bluestore_wal_devices: - /dev/nvme0n1 - /dev/nvme0n2

첫 번째 시나리오에는 두 개의 OSD가 있습니다.

sda및sdb장치에는 각각 자체 데이터 세그먼트와 write-ahead 로그가 있습니다. 추가 사전dedicated_devices는 각각sdx및sdy에서block.db라고도 하는 데이터베이스를 격리하는 데 사용됩니다.두 번째 시나리오에서 다른 추가 사전

bluestore_wal_devices는 NVMe 장치nvme0n1및nvme0n2에서 write-ahead 로그를 격리하는 데 사용됩니다.장치,dedicated_devices및bluestore_wal_devices를 함께 사용하면 OSD의 모든 구성 요소를 별도의 장치에 분리할 수 있습니다. 이와 같이 OSD를 배치하면 전반적인 성능이 향상될 수 있습니다.미리 생성된 논리 볼륨

첫 번째 시나리오

lvm_volumes: - data: data-lv1 data_vg: data-vg1 db: db-lv1 db_vg: db-vg1 wal: wal-lv1 wal_vg: wal-vg1 - data: data-lv2 data_vg: data-vg2 db: db-lv2 db_vg: db-vg2 wal: wal-lv2 wal_vg: wal-vg2또는

두 번째 시나리오

lvm_volumes: - data: /dev/sdb db: db-lv1 db_vg: db-vg1 wal: wal-lv1 wal_vg: wal-vg1기본적으로 Ceph는 논리 볼륨 관리자를 사용하여 OSD 장치에 논리 볼륨을 생성합니다. 위의 간단한 구성 및 고급 구성 예제에서 Ceph는 장치에 논리 볼륨을 자동으로 생성합니다.

lvm_volumes사전을 지정하여 Ceph에서 이전에 생성한 논리 볼륨을 사용할 수 있습니다.첫 번째 시나리오에서는 데이터가 전용 논리 볼륨, 데이터베이스 및 WAL에 배치됩니다. 데이터, 데이터 및 WAL 또는 데이터 및 데이터베이스만 지정할 수도 있습니다.

data:행은 데이터를 저장할 논리 볼륨 이름을 지정해야 하며data_vg:는 데이터 논리 볼륨이 포함된 볼륨 그룹의 이름을 지정해야 합니다. 마찬가지로db:는 데이터베이스가 저장된 논리 볼륨을 지정하는 데 사용되며,db_vg:는 논리 볼륨이 있는 볼륨 그룹을 지정하는 데 사용됩니다.wal:행은 WAL이 저장된 논리 볼륨을 지정하고wal_vg:행은 해당 볼륨이 포함된 볼륨 그룹을 지정합니다.두 번째 시나리오에서는

data:option에 대해 실제 장치 이름이 설정되며, 이렇게 하면data_vg:옵션을 지정할 필요가 없습니다. BlueStore 데이터베이스 및 WAL 장치의 논리 볼륨 이름과 볼륨 그룹 세부 정보를 지정해야 합니다.중요lvm_volumes:를 사용하면 볼륨 그룹과 논리 볼륨을 미리 만들어야 합니다. 볼륨 그룹과 논리 볼륨은ceph-anible에서 생성되지 않습니다.참고모든 NVMe SSD를 사용하는 경우

osds_per_device를 설정합니다. 2. 자세한 내용은 Red Hat Ceph Storage 설치 가이드의 모든 NVMe 스토리지에 대한 OSD Ansible 설정 구성을 참조하십시오.참고Ceph OSD 노드를 재부팅한 후에는 블록 장치 할당이 변경될 수 있습니다. 예를 들어

sdc는sdd가 될 수 있습니다. 기존 블록 장치 이름 대신/dev/disk/by-path/장치 경로와 같은 영구적인 이름 지정 장치를 사용할 수 있습니다.

베어 메탈 또는 컨테이너에 있는 모든 배포의 경우 Ansible 인벤토리 파일을 생성한 다음 편집을 위해 엽니다.

[root@admin ~]# cd /usr/share/ceph-ansible/ [root@admin ceph-ansible]# touch hosts

그에 따라

hosts파일을 편집합니다.참고Ansible 인벤토리 위치 편집에 대한 자세한 내용은 Ansible 인벤토리 위치 구성을 참조하십시오.

[grafana-server]아래에 노드를 추가합니다. 이 역할은 Grafana 및 Prometheus를 설치하여 Ceph 클러스터의 성능에 대한 실시간 정보를 제공합니다. 이러한 지표는 Ceph 대시보드에 제공되어 클러스터를 모니터링하고 관리할 수 있습니다. 대시보드, Grafana 및 Prometheus를 설치해야 합니다. Ansible 관리 노드에서 지표 기능을 배치할 수 있습니다. 이 경우 노드의 시스템 리소스가 독립형 메트릭 노드에 필요한 것보다 큰지 확인하십시오.[grafana-server] GRAFANA-SERVER_NODE_NAME[mons]섹션 아래에 모니터 노드를 추가합니다.[mons] MONITOR_NODE_NAME_1 MONITOR_NODE_NAME_2 MONITOR_NODE_NAME_3

[osds]섹션에 OSD 노드를 추가합니다.[osds] OSD_NODE_NAME_1 OSD_NODE_NAME_2 OSD_NODE_NAME_3

참고노드 이름이 숫자 순차적이면 범위 지정자(

[1:10])를 노드 이름 끝에 추가할 수 있습니다. 예를 들어 다음과 같습니다.[osds] example-node[1:10]

참고새 설치의 OSD의 경우 기본 오브젝트 저장소 형식은 BlueStore입니다.

-

선택적으로, 컨테이너 배포에서

[mon]및[osd]섹션에서 동일한 노드를 추가하여 Ceph OSD 데몬을 하나의 노드의 Ceph OSD 데몬과 함께 연결합니다. 아래 추가 리소스 섹션에서 자세한 내용은 Ceph 데몬 일치 링크를 참조하십시오. [mgrs]섹션에 Ceph Manager(ceph-mgr) 노드를 추가합니다. Ceph Monitor 데몬을 사용하여 Ceph Manager 데몬을 배치합니다.[mgrs] MONITOR_NODE_NAME_1 MONITOR_NODE_NAME_2 MONITOR_NODE_NAME_3

선택적으로 모든 배포, 베어 메탈 또는 컨테이너에 대해 호스트 특정 매개 변수를 사용하려면 호스트 파일과 함께

host_vars디렉터리를 생성하여 호스트와 관련된 모든 매개변수를 포함합니다.host_vars디렉터리를 생성합니다.[ansible@admin ~]$ mkdir /usr/share/ceph-ansible/host_vars

host_vars디렉터리로 변경합니다.[ansible@admin ~]$ cd /usr/share/ceph-ansible/host_vars

호스트 파일을 생성합니다. 파일 이름에 host-name-short-name 형식을 사용합니다. 예를 들면 다음과 같습니다.

[ansible@admin host_vars]$ touch tower-osd6

호스트별 매개변수를 사용하여 파일을 업데이트합니다. 예를 들면 다음과 같습니다.

베어 메탈 배포에서는

devices매개 변수를 사용하여 OSD 노드에서 사용할 장치를 지정합니다. OSD에서장치를사용하면 OSD에서 이름이 다른 장치를 사용하거나 장치 중 하나가 OSD에서 실패한 경우 유용합니다.devices: DEVICE_1 DEVICE_2예제

devices: /dev/sdb /dev/sdc참고장치를 지정하지 않는 경우

group_vars/osds.yml파일에서osd_auto_discovery매개변수를true로 설정합니다.

필요한 경우 모든 배포, 베어 메탈 또는 컨테이너 의 경우 Ceph Ansible을 사용하여 사용자 지정 NetNamespace 계층 구조를 만들 수 있습니다.

Ansible 인벤토리 파일을 설정합니다.

osd_crush_location매개변수를 사용하여 OSD 호스트의 계층 구조에 OSD 호스트가 될 위치를 지정합니다. OSD의 위치를 지정하려면 두 개 이상의 ArgoCD 버킷 유형을 지정해야 하며 하나의 버킷유형이호스트여야 합니다. 기본적으로root,datacenter,room,row,pod,pdu,rack,섀시및호스트가포함됩니다.구문

[osds] CEPH_OSD_NAME osd_crush_location="{ 'root': ROOT_BUCKET_', 'rack': 'RACK_BUCKET', 'pod': 'POD_BUCKET', 'host': 'CEPH_HOST_NAME' }"

예제

[osds] ceph-osd-01 osd_crush_location="{ 'root': 'default', 'rack': 'rack1', 'pod': 'monpod', 'host': 'ceph-osd-01' }"group_vars/osds.yml파일을 편집하고crush_rule_config및create_crush_tree매개 변수를True로 설정합니다. 기본 NetNamespace 규칙을 사용하지 않는 경우 하나 이상의 NetNamespace 규칙을 만듭니다. 예를 들면 다음과 같습니다.crush_rule_config: True crush_rule_hdd: name: replicated_hdd_rule root: root-hdd type: host class: hdd default: True crush_rules: - "{{ crush_rule_hdd }}" create_crush_tree: True더 빠른 SSD 장치를 사용하는 경우 다음과 같이 매개변수를 편집합니다.

crush_rule_config: True crush_rule_ssd: name: replicated_ssd_rule root: root-ssd type: host class: ssd default: True crush_rules: - "{{ crush_rule_ssd }}" create_crush_tree: True참고기본 규칙에는 정의해야 하는

class매개 변수가 포함되어 있으므로ssd및hddOSD가 모두 배포되지 않으면 기본 nmap 규칙이 실패합니다.group_vars/clients.yml파일에crush_rules를 생성한 상태에서풀을 생성합니다.예제

copy_admin_key: True user_config: True pool1: name: "pool1" pg_num: 128 pgp_num: 128 rule_name: "HDD" type: "replicated" device_class: "hdd" pools: - "{{ pool1 }}"트리 보기:

[root@mon ~]# ceph osd tree

풀을 검증합니다.

[root@mon ~]# for i in $(rados lspools); do echo "pool: $i"; ceph osd pool get $i crush_rule; done pool: pool1 crush_rule: HDD

모든 배포의 경우 베어 메탈 또는 컨테이너에 대해 로그인하거나

ansible사용자로 전환합니다.Ansible이

ceph-ansible플레이북에서 생성한 임시 값을 저장하는ceph-ansible-keys디렉터리를 생성합니다.[ansible@admin ~]$ mkdir ~/ceph-ansible-keys

/usr/share/ceph-ansible/디렉토리로 변경합니다.[ansible@admin ~]$ cd /usr/share/ceph-ansible/

Ansible이 Ceph 노드에 연결할 수 있는지 확인합니다.

[ansible@admin ceph-ansible]$ ansible all -m ping -i hosts

ceph-ansible플레이북을 실행합니다.베어 메탈 배포:

[ansible@admin ceph-ansible]$ ansible-playbook site.yml -i hosts

컨테이너 배포:

[ansible@admin ceph-ansible]$ ansible-playbook site-container.yml -i hosts

참고Red Hat Ceph Storage를 Red Hat Enterprise Linux Atomic Host 호스트에 배포하는 경우

--skip-tags=with_pkg옵션을 사용합니다.[user@admin ceph-ansible]$ ansible-playbook site-container.yml --skip-tags=with_pkg -i hosts

참고배포 속도를 높이려면

ansible-playbook에--forks옵션을 사용합니다. 기본적으로ceph-ansible세트는 포크를20으로 설정합니다. 이 설정을 사용하면 최대 20개의 노드가 동시에 설치됩니다. 한 번에 최대 30개의 노드를 설치하려면ansible-playbook --forks 30 PLAYBOOK Files - i 호스트를실행합니다. 과다하게 사용되지 않도록 관리 노드의 리소스를 모니터링해야 합니다. 이러한 값이 있는 경우--forks에 전달되는 수를 줄입니다.

Ceph 배포가 완료될 때까지 기다립니다.

출력 예

INSTALLER STATUS ******************************* Install Ceph Monitor : Complete (0:00:30) Install Ceph Manager : Complete (0:00:47) Install Ceph OSD : Complete (0:00:58) Install Ceph RGW : Complete (0:00:34) Install Ceph Dashboard : Complete (0:00:58) Install Ceph Grafana : Complete (0:00:50) Install Ceph Node Exporter : Complete (0:01:14)

Ceph 스토리지 클러스터의 상태를 확인합니다.

베어 메탈 배포:

[root@mon ~]# ceph health HEALTH_OK

컨테이너 배포:

Red Hat Enterprise Linux 7

[root@mon ~]# docker exec ceph-mon-ID ceph healthRed Hat Enterprise Linux 8

[root@mon ~]# podman exec ceph-mon-ID ceph health- 대체 버전

Ceph Monitor 노드의 호스트 이름이 있는

ID:예제

[root@mon ~]# podman exec ceph-mon-mon0 ceph health HEALTH_OK

모든 배포에서는 베어 메탈 또는 컨테이너에 대해

rados를 사용하여 스토리지 클러스터가 작동하는지 확인합니다.Ceph Monitor 노드에서 8개의 배치 그룹(PG)이 있는 테스트 풀을 생성합니다.

구문

[root@mon ~]# ceph osd pool create POOL_NAME PG_NUMBER

예제

[root@mon ~]# ceph osd pool create test 8

hello-world.txt라는 파일을 생성합니다.구문

[root@mon ~]# vim FILE_NAME예제

[root@mon ~]# vim hello-world.txt

hello-world라는 오브젝트를 사용하여 test 풀에hello-world.txt를 업로드합니다.구문

[root@mon ~]# rados --pool POOL_NAME put OBJECT_NAME OBJECT_FILE_NAME

예제

[root@mon ~]# rados --pool test put hello-world hello-world.txt

테스트 풀에서

hello-world를 파일 이름fetch.txt로 다운로드합니다.구문

[root@mon ~]# rados --pool POOL_NAME get OBJECT_NAME OBJECT_FILE_NAME

예제

[root@mon ~]# rados --pool test get hello-world fetch.txt

fetch.txt내용을 확인합니다.[root@mon ~]# cat fetch.txt "Hello World!"

참고스토리지 클러스터 상태를 확인하는 것 외에도

ceph-medic유틸리티를 사용하여 Ceph Storage 클러스터를 전반적으로 진단할 수 있습니다. Red Hat Ceph Storage 4 문제 해결 가이드의 Ceph Storage 클러스터 진단을 위한ceph-medic설치 및 사용 장을 참조하십시오.

추가 리소스

- 공통 Ansible 설정 목록입니다.

- 일반 OSD 설정 목록입니다.

- 자세한 내용은 컨테이너화된 Ceph 데몬 공동 배치를 참조하십시오.

5.3. 모든 NVMe 스토리지에 대한 OSD Ansible 설정 구성

전체 성능을 높이기 위해 스토리지에 NVMe(Non-volatile memory express) 장치만 사용하도록 Ansible을 구성할 수 있습니다. 일반적으로 장치당 하나의 OSD만 구성되어 있으므로 NVMe 장치의 처리량이 향상됩니다.

SSD와HD를 혼합하면 OSD의 데이터가 아닌 데이터베이스에 SSD가 사용되거나 block.db 가 사용됩니다.

테스트에서 최적의 성능을 제공하는 각 NVMe 장치에서 OSD를 두 개 구성하는 것이 확인되었습니다. Red Hat은 osds_per_device 옵션을 2 로 설정하는 것을 권장하지만 필수는 아닙니다. 다른 값은 환경에 더 나은 성능을 제공할 수 있습니다.

사전 요구 사항

- Ansible 관리 노드에 액세스합니다.

-

ceph-ansible패키지 설치.

절차

osds_per_device를 설정합니다. 2ingroup_vars/osds.yml:osds_per_device: 2

장치 아래에 NVMe 장치를 나열합니다.

devices: - /dev/nvme0n1 - /dev/nvme1n1 - /dev/nvme2n1 - /dev/nvme3n1

group_vars/osds.yml의 설정은 다음 예와 유사합니다.osds_per_device: 2 devices: - /dev/nvme0n1 - /dev/nvme1n1 - /dev/nvme2n1 - /dev/nvme3n1

lvm_volumes 가 아닌 이 구성으로 장치를 사용해야 합니다. 이는 lvm_volumes 가 일반적으로 미리 생성된 논리 볼륨에 사용되며 osds_per_device 는 Ceph에서 자동 논리 볼륨 생성을 의미하기 때문입니다.

추가 리소스

- 자세한 내용은 Red Hat Ceph Storage 설치 가이드에서 Red Hat Ceph Storage 클러스터 설치를 참조하십시오.

5.4. 메타데이터 서버 설치

Ansible 자동화 애플리케이션을 사용하여 Ceph 메타데이터 서버(MDS)를 설치합니다. 메타데이터 서버 데몬은 Ceph 파일 시스템을 배포하는 데 필요합니다.

사전 요구 사항

- 작동 중인 Red Hat Ceph Storage 클러스터.

- 암호 없는 SSH 액세스를 활성화합니다.

절차

Ansible 관리 노드에서 다음 단계를 수행합니다.

새 섹션

[mds]을/etc/ansible/hosts파일에 추가합니다.[mdss] MDS_NODE_NAME1 MDS_NODE_NAME2 MDS_NODE_NAME3

MDS_NODE_NAME 을 Ceph 메타데이터 서버를 설치하려는 노드의 호스트 이름으로 바꿉니다.

또는

[osds]및[mds]섹션에 동일한 노드를 추가하여 메타데이터 서버를 한 노드의 OSD 데몬과 함께 배치할 수 있습니다./usr/share/ceph-ansible디렉토리로 이동합니다.[root@admin ~]# cd /usr/share/ceph-ansible

선택적으로 기본 변수를 변경할 수 있습니다.

mdss.yml이라는group_vars/mds.yml.sample파일의 사본을 만듭니다.[root@admin ceph-ansible]# cp group_vars/mdss.yml.sample group_vars/mdss.yml

-

선택적으로

mdss.yml의 매개변수를 편집합니다. 자세한 내용은mdss.yml을 참조하십시오.

ansible사용자로 Ansible 플레이북을 실행합니다.베어 메탈 배포:

[user@admin ceph-ansible]$ ansible-playbook site.yml --limit mdss -i hosts

컨테이너 배포:

[ansible@admin ceph-ansible]$ ansible-playbook site-container.yml --limit mdss -i hosts