대시보드 가이드

Ceph 대시보드를 사용하여 Ceph 클러스터 모니터링

초록

1장. Ceph 대시보드 개요

스토리지 관리자인 Red Hat Ceph Storage 대시보드는 관리 및 모니터링 기능을 제공하므로 클러스터를 관리하고 구성할 수 있으며 관련 정보와 성능 통계를 시각화할 수 있습니다. 대시보드는 ceph-mgr 데몬에서 호스팅하는 웹 서버를 사용합니다.

대시보드는 웹 브라우저에서 액세스할 수 있으며, 관리자 모듈을 구성하고 OSD 상태를 모니터링하기 위해 유용한 관리 및 모니터링 기능이 많이 포함되어 있습니다.

1.1. 사전 요구 사항

- 시스템 관리자 수준 경험.

1.2. 대시보드 구성 요소

대시보드 기능은 여러 구성 요소에서 제공합니다.

- 배포를 위한 Ansible 자동화 애플리케이션입니다.

-

포함된 대시보드

ceph-mgr모듈. -

포함된 Prometheus

ceph-mgr모듈. - Prometheus 시계열 데이터베이스.

- 스토리지 클러스터의 각 노드에서 실행되는 Prometheus node-exporter 데몬.

- 모니터링 사용자 인터페이스 및 경고를 제공하는 Grafana 플랫폼입니다.

추가 리소스

- 자세한 내용은 Ansible 웹 사이트를참조하십시오.

- 자세한 내용은 Prometheus 웹 사이트를 참조하십시오.

- 자세한 내용은 Grafana 웹 사이트를 참조하십시오.

1.3. 대시보드 기능

Ceph 대시보드는 여러 기능을 제공합니다.

관리 기능

- 클러스터 계층 구조 보기: 예를 들어 CRUSH 맵을 보고 특정 OSD ID가 실행 중인 노드를 확인할 수 있습니다. OSD에 문제가 있는 경우 유용합니다.

- 관리자 모듈 구성: ceph manager 모듈의 매개 변수를 보고 변경할 수 있습니다.

- 보기 및 필터 로그: 이벤트 및 감사 클러스터 로그를 보고 우선 순위, 키워드, 날짜 또는 시간 범위를 기반으로 필터링할 수 있습니다.

- 대시보드 구성 요소 토글: 필요한 기능만 사용할 수 있도록 대시보드 구성 요소를 활성화하고 비활성화할 수 있습니다.

- OSD 설정 관리: 대시보드를 사용하여 클러스터 전체 OSD 플래그를 설정할 수 있습니다.

- 경고 보기: 경고 페이지를 사용하면 현재 알림에 대한 세부 정보를 볼 수 있습니다.

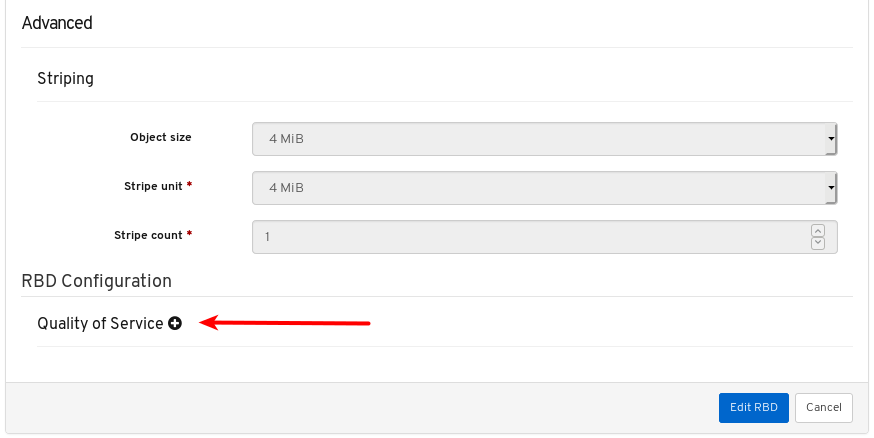

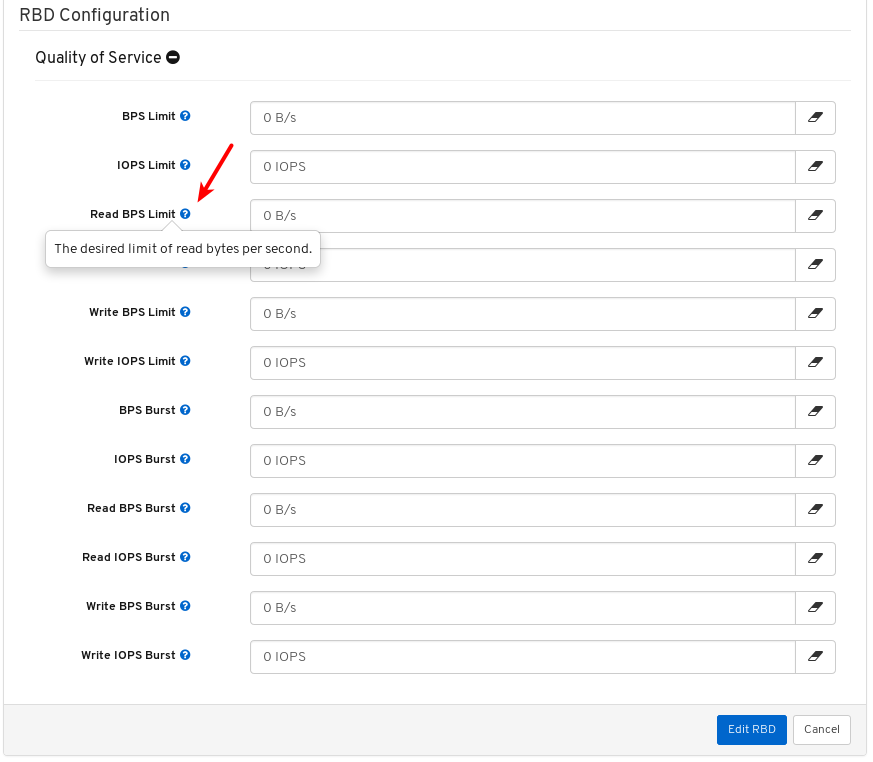

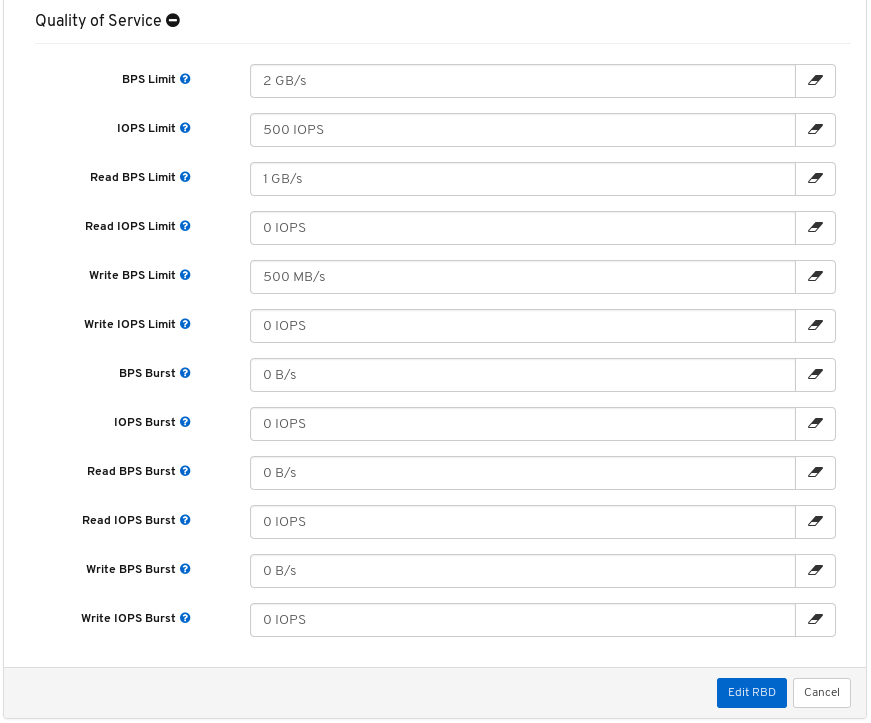

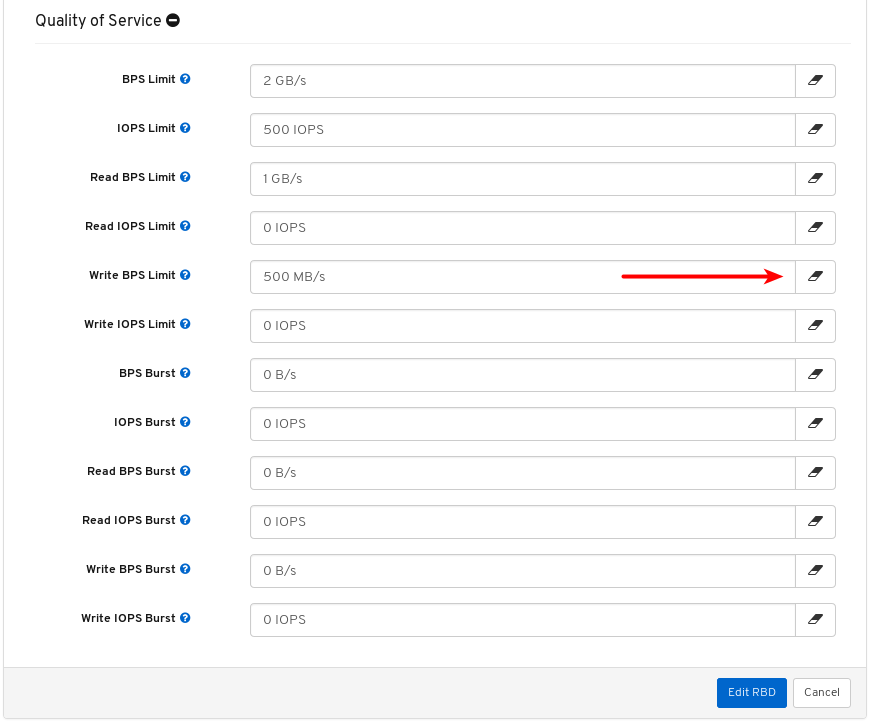

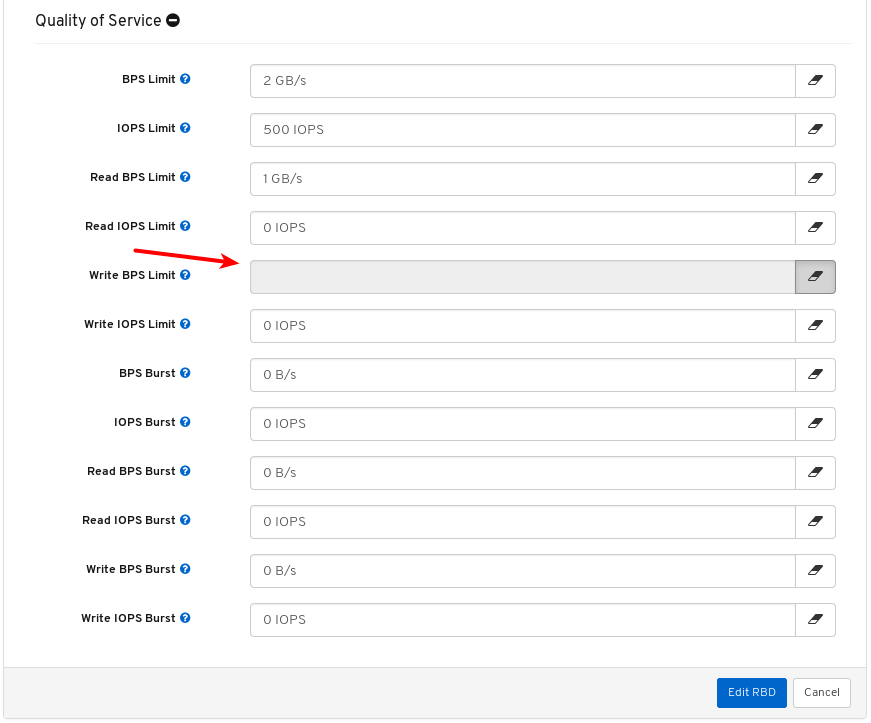

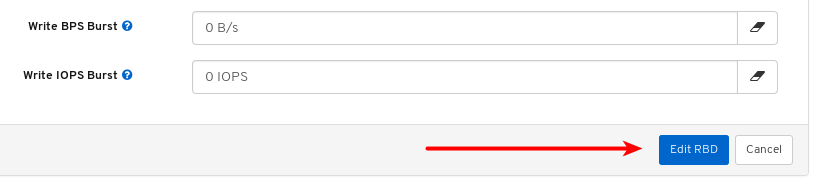

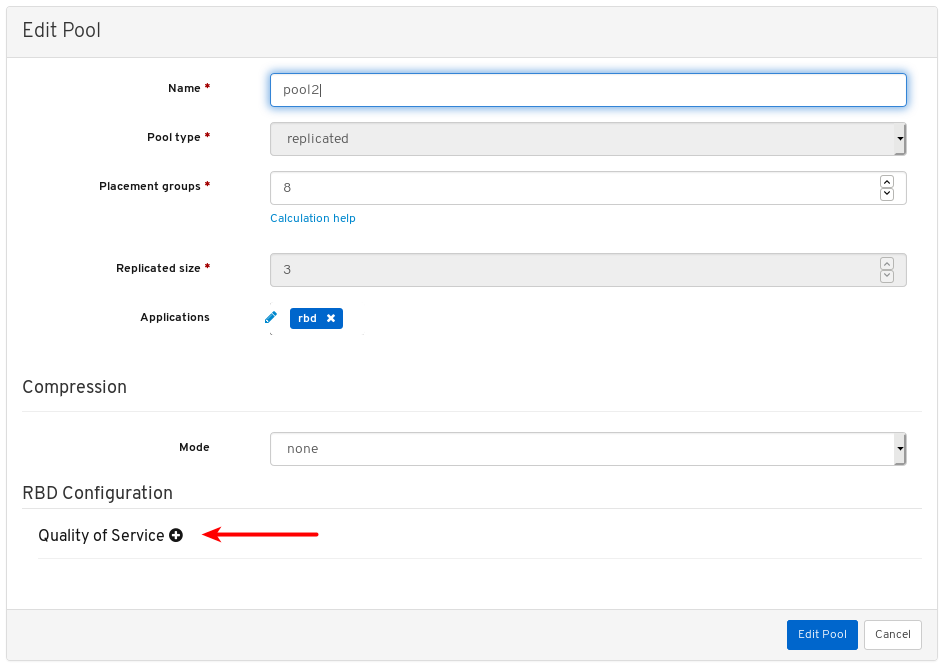

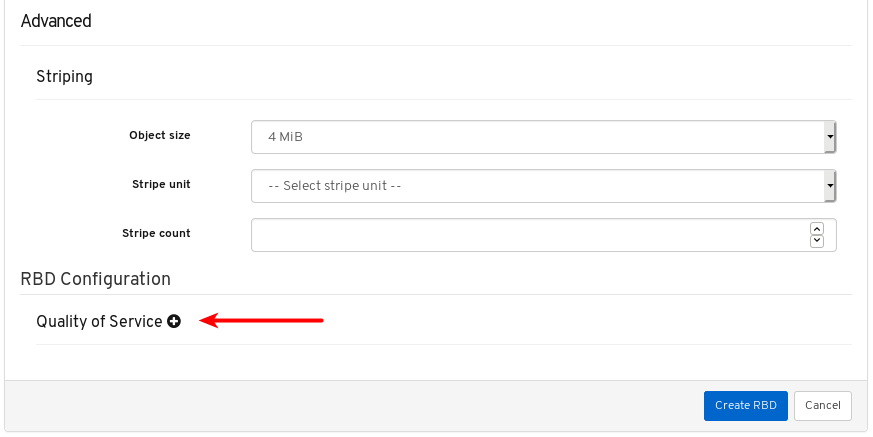

- 이미지 품질: 이미지에 대한 성능 제한을 설정할 수 있습니다(예: IOPS 제한 또는 읽기 BPS 버스트 속도 제한).

모니터링 기능

- 사용자 이름 및 암호 보호: 구성 가능한 사용자 이름과 암호를 제공하여 대시보드에 액세스할 수 있습니다.

SSL 및 TLS 지원: 웹 브라우저와 대시보드 간의 모든 HTTP 통신은 SSL을 통해 보호됩니다. 자체 서명된 인증서는 기본 제공 명령을 사용하여 생성할 수 있지만 CA(인증 기관)에서 서명하고 발행하는 사용자 정의 인증서를 가져올 수도 있습니다. Red Hat Ceph Storage 4.2에서

dashboard_protocol은https로 설정되고 Ansible은 대시보드 및 grafana 인증서를 생성합니다. 데이터 지점 및 그래프를 플롯하려면 다음과 같이 TLS 핸드셰이크를 수동으로 업데이트합니다.- 경고 관리자 API 호스트 - http://grafana_node:9093

- Prometheus API 호스트 - http://grafana_node:9092

- Grafana API 호스트 - https://grafana_node:3000

- 전체 클러스터 상태: 전체 클러스터 상태, 스토리지 사용률(예: 오브젝트 수, 원시 용량, 풀당 사용량), 풀 목록 및 해당 상태 및 사용량 통계를 표시합니다.

- hosts: 실행 중인 서비스 및 설치된 Ceph 버전과 함께 클러스터와 연결된 모든 호스트 목록을 제공합니다.

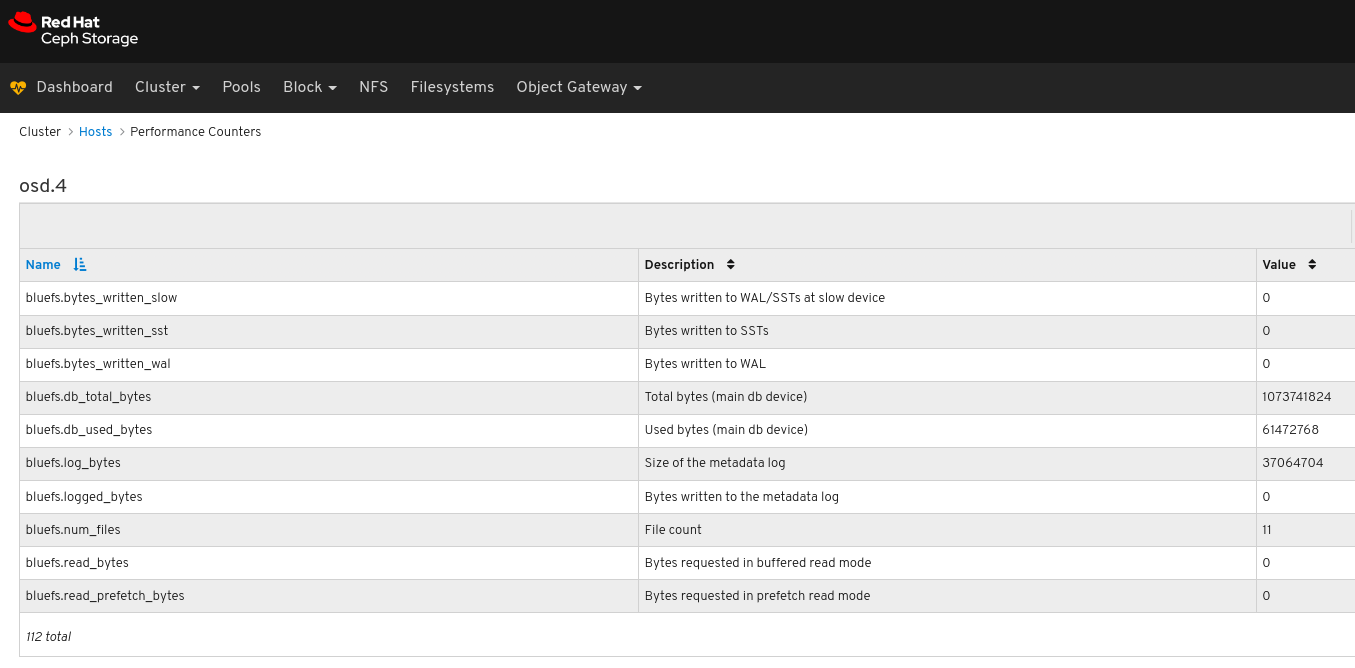

- 성능 카운터: 실행 중인 각 서비스에 대한 자세한 통계를 표시합니다.

- monitors: 모든 모니터, 쿼럼 상태 및 열려 있는 세션을 나열합니다.

- Configuration Reference: 사용 가능한 모든 구성 옵션, 해당 설명 및 기본값을 나열합니다.

- 클러스터 로그: 클러스터의 이벤트 및 감사 로그를 표시하고 필터링합니다.

- 스토리지 클러스터 용량 보기: Ceph 대시보드의 용량 패널에서 Red Hat Ceph Storage 클러스터의 원시 스토리지 용량 을 볼 수 있습니다.

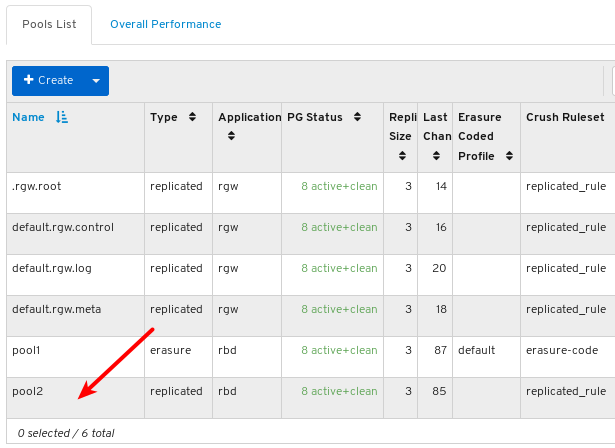

- pool: 모든 Ceph 풀 및 세부 정보를 나열하고 관리합니다. 예를 들어 애플리케이션, 배치 그룹, 복제 크기, EC 프로파일, CRUSH 규칙 세트 등입니다.

- OSD: 모든 OSD, 상태 및 사용량 통계, 속성(OSD 맵), 메타데이터, 성능 카운터, 읽기/쓰기 작업에 대한 사용 히스토그램을 나열하고 관리합니다.

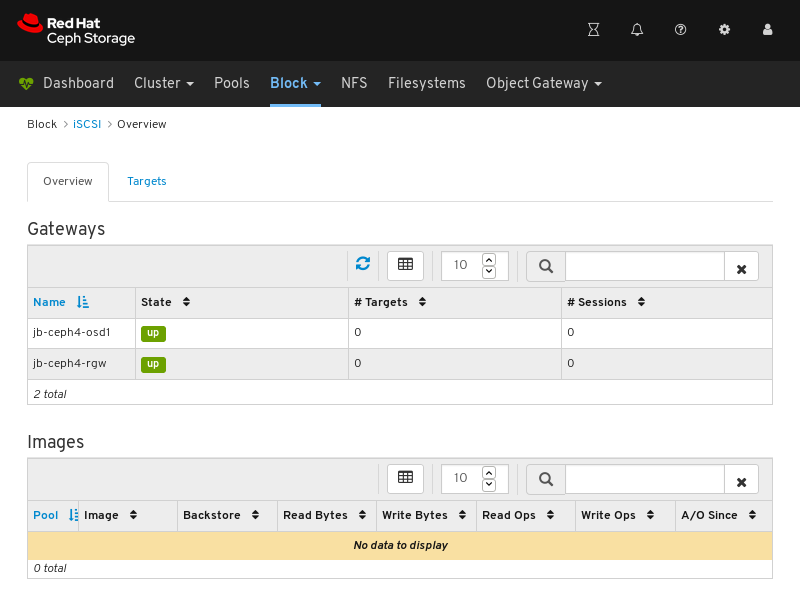

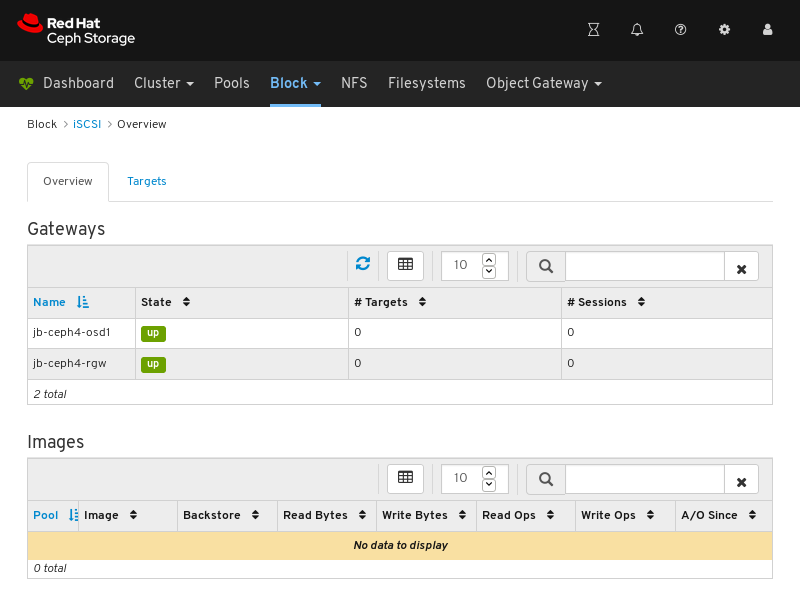

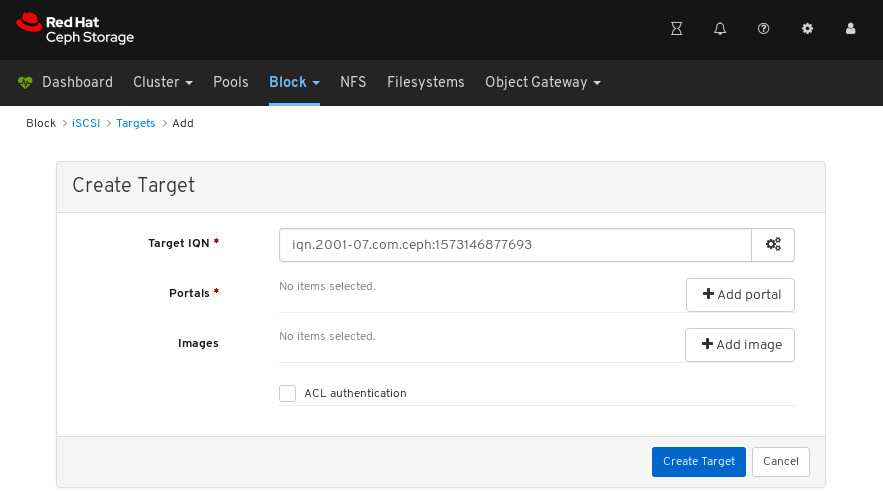

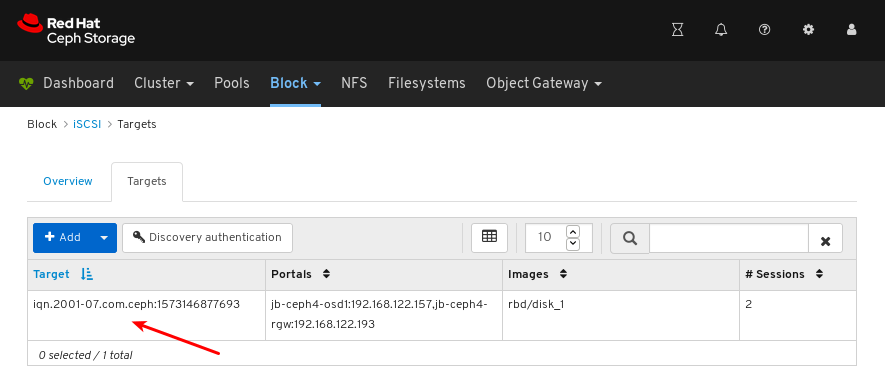

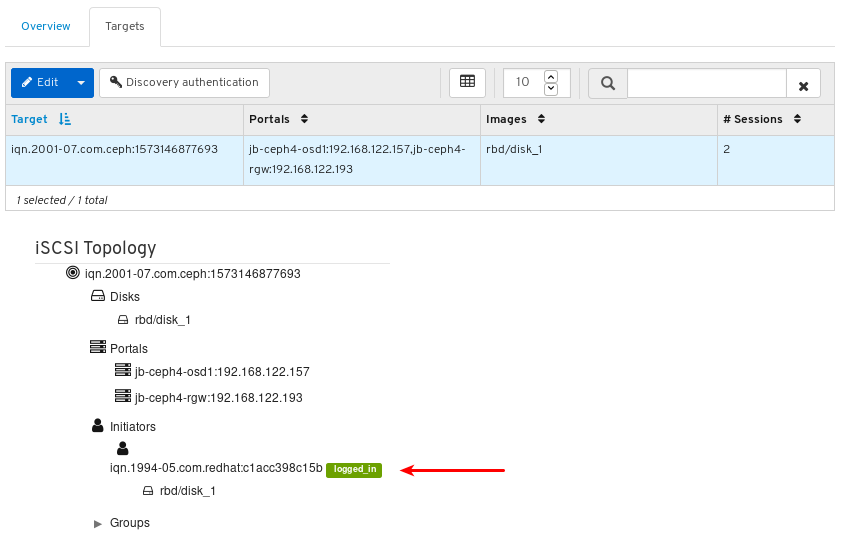

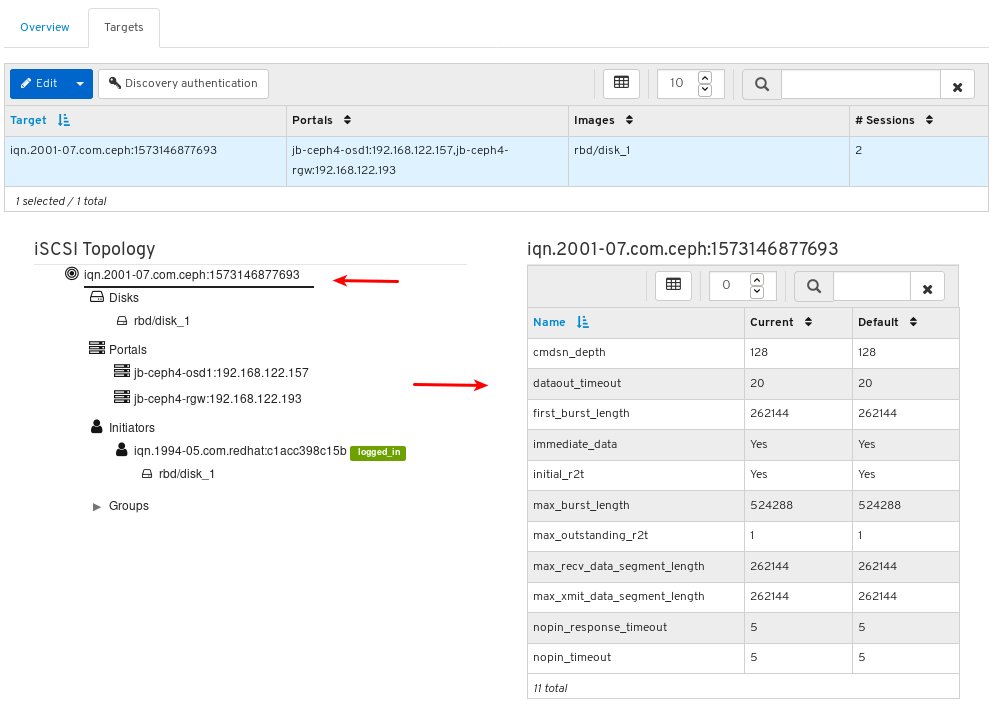

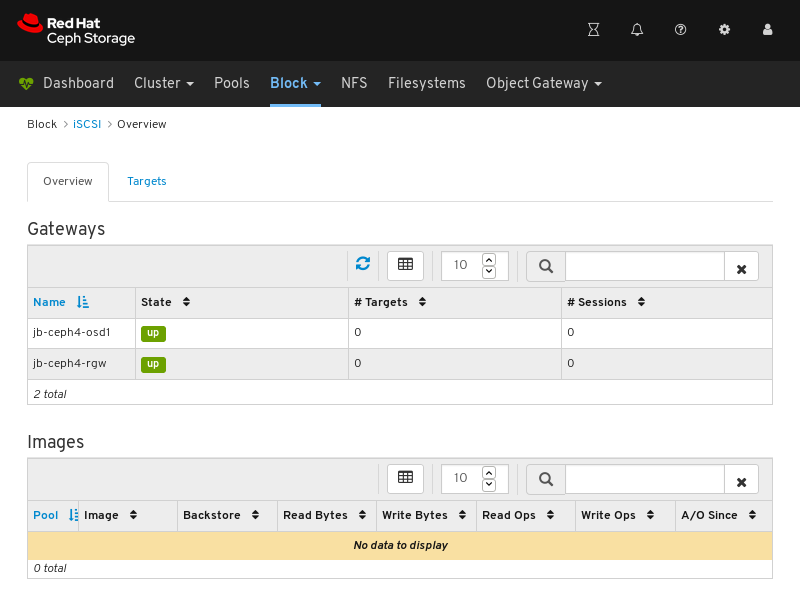

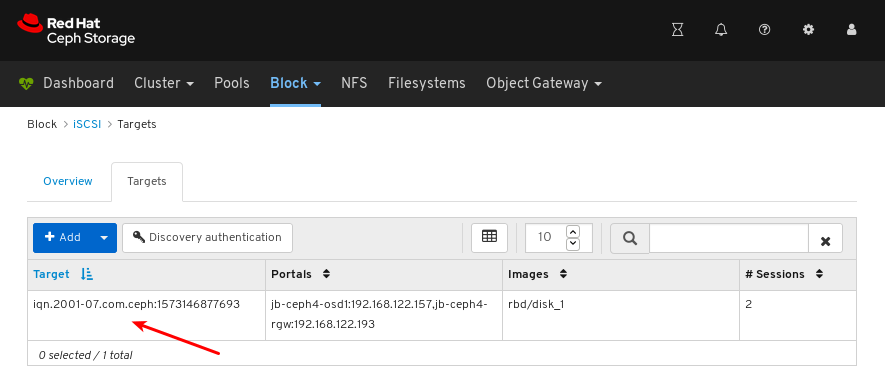

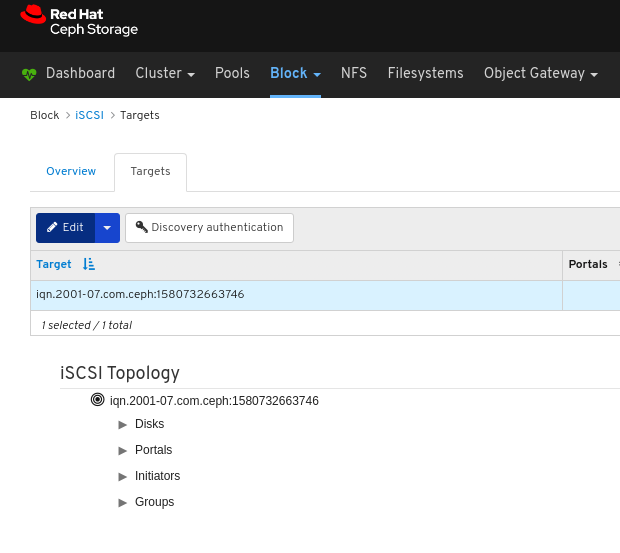

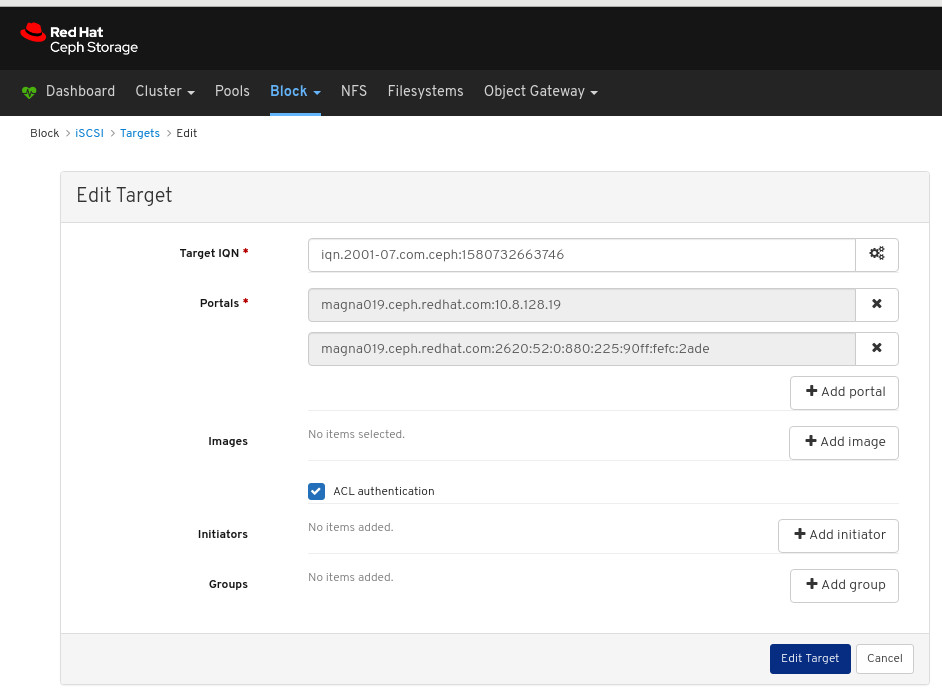

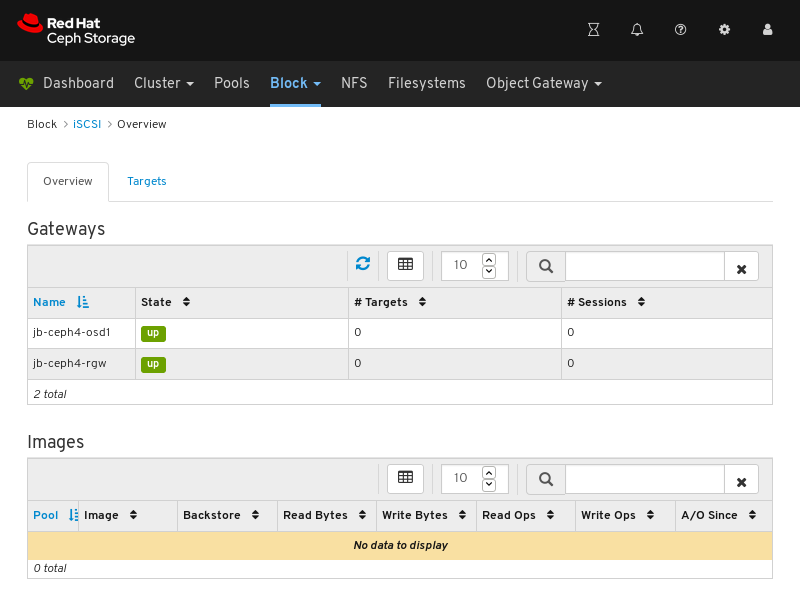

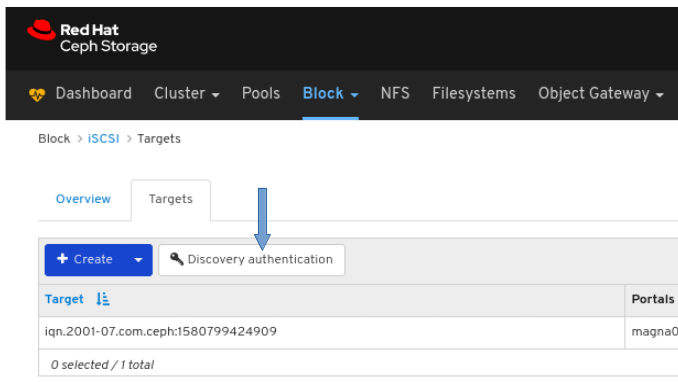

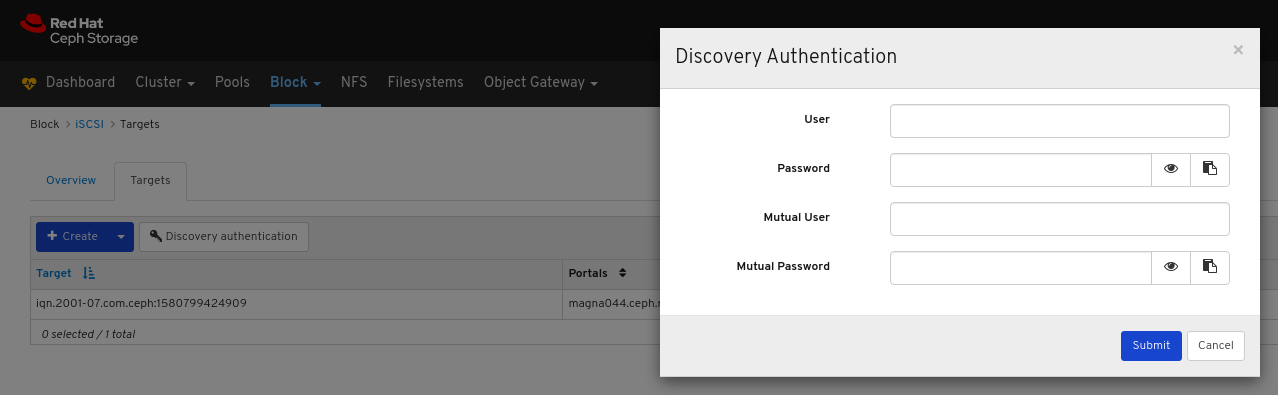

- iSCSI: tcmu-runner 서비스를 실행하는 모든 호스트를 나열하고 모든 이미지와 해당 성능 특성(예: 읽기 및 쓰기 작업 또는 트래픽)을 표시합니다.

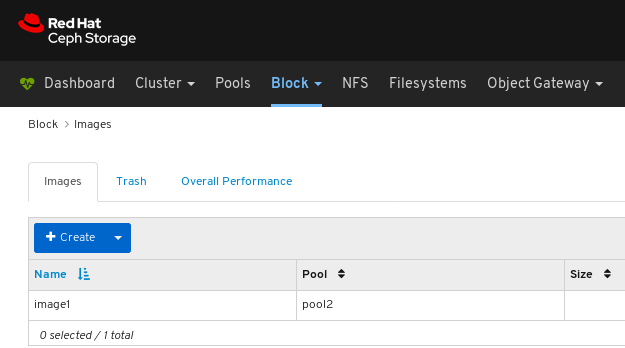

images: 모든 RBD 이미지와 크기, 개체 및 기능과 같은 해당 속성을 나열합니다. RBD 이미지를 생성, 복사, 수정 및 삭제합니다. 선택한 이미지의 스냅샷을 생성, 삭제 및 롤백하고, 이러한 스냅샷을 수정으로부터 보호하거나 보호 해제합니다. 스냅샷 복사 또는 복제, 플랫 복제 이미지.

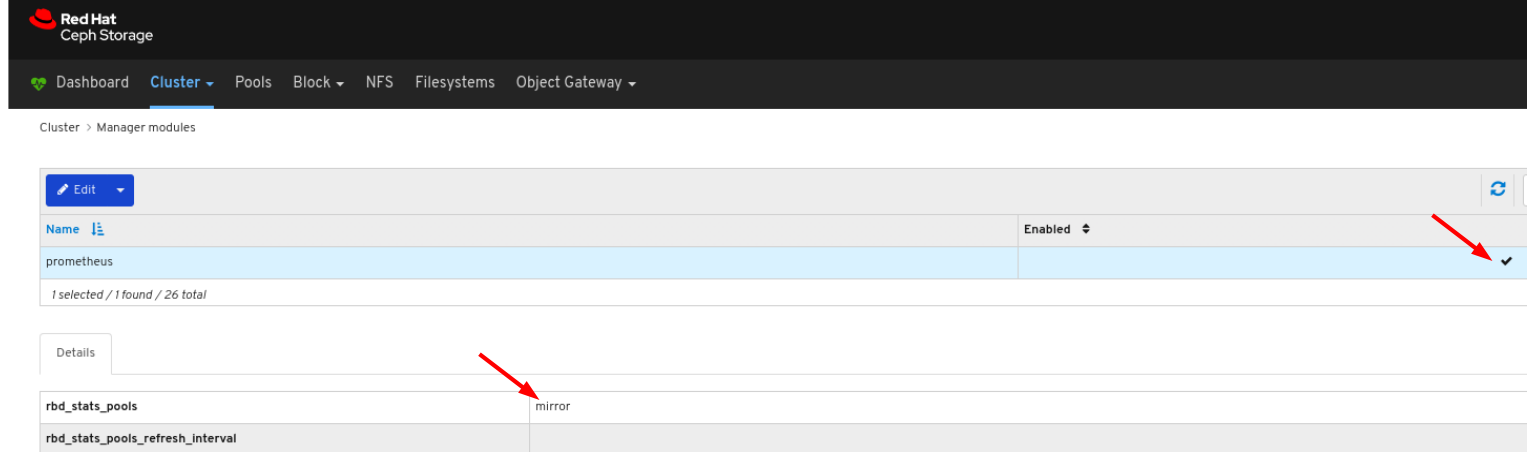

참고특정 이미지에 대한 Overall Performance 탭의 I/O 변경 성능 그래프는 Cluster > Manager 모듈 > Prometheus 에서

rbd_stats_pool매개변수를 설정하여 해당 이미지가 포함된 풀을 지정하는 경우에만 값을 표시합니다.- mirroring: 동기화 상태를 포함하여 모든 활성 동기화 데몬과 해당 상태, 풀 및 RBD 이미지를 나열합니다.

- 파일 시스템: 사용 통계를 포함하여 모든 활성 Ceph 파일 시스템(CephFS) 클라이언트 및 관련 풀을 나열합니다.

- RGW: 모든 활성 개체 게이트웨이 및 해당 성능 카운터를 나열합니다. 표시 및 관리(추가, 편집, 삭제) 오브젝트 게이트웨이 사용자와 해당 세부 정보(예: 할당량 등), 사용자의 버킷 및 세부 정보(예: 소유자 또는 할당량)를 표시 및 관리합니다.

추가 리소스

1.3.1. 대시보드 기능 전환 또는 해제

필요에 따라 기능을 활성화하거나 비활성화하여 Red Hat Ceph Storage 대시보드 구성 요소를 사용자 지정할 수 있습니다. 모든 기능은 기본적으로 활성화되어 있습니다. 기능을 비활성화하면 웹 인터페이스 요소가 숨겨지고 연결된 REST API 엔드포인트가 해당 기능에 대한 추가 요청을 거부합니다. 대시보드 기능 활성화 및 비활성화는 명령줄 인터페이스 또는 웹 인터페이스에서 수행할 수 있습니다.

사용 가능한 기능:

Ceph 블록 장치:

-

이미지 관리,

rbd -

미러링,

미러링 -

iSCSI 게이트웨이,

iscsi

-

이미지 관리,

-

Ceph Filesystem,

cephfs -

Ceph Object Gateway,

rgw

기본적으로 Ceph Manager는 Ceph Monitor와 함께 배치됩니다.

여러 기능을 한 번에 비활성화할 수 있습니다.

기능을 비활성화하면 웹 인터페이스의 변경 사항을 반영하려면 최대 20초가 걸릴 수 있습니다.

사전 요구 사항

- Red Hat Ceph Storage 대시보드 소프트웨어의 설치 및 구성.

- Ceph Manager 노드 또는 대시보드 웹 인터페이스에 대한 사용자 액세스 권한.

절차

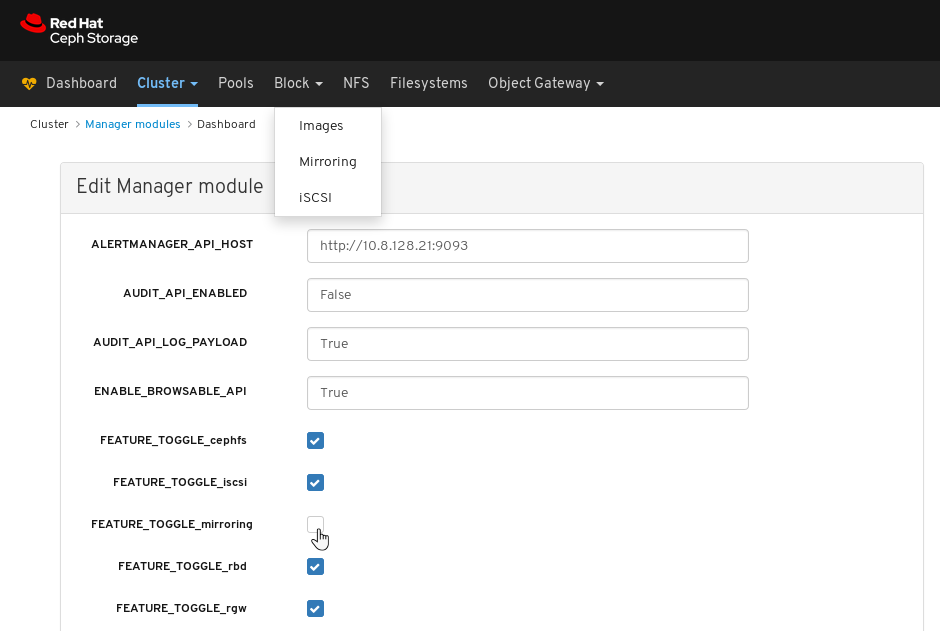

대시보드 웹 인터페이스에서 대시보드 기능을 전환하려면 다음을 수행합니다.

- 대시보드 페이지의 탐색 모음에서 Cluster, Manager 모듈 으로 이동한 다음 대시보드 를 클릭합니다. 그러면 Edit Manager 모듈 페이지가 열립니다.

Edit Manager 모듈 페이지에서 기능 이름 옆에 있는 선택 상자를 선택하거나 선택 상자를 선택하여 대시보드 기능을 활성화하거나 비활성화할 수 있습니다.

선택 항목이 완료되면 페이지 하단에 있는 업데이트 버튼을 클릭합니다.

명령줄 인터페이스에서 대시보드 기능을 전환하려면 다음을 수행합니다.

- Ceph Manager 노드에 로그인합니다.

기능 상태를 나열합니다.

[user@mon ~]$ ceph dashboard feature status

기능을 비활성화합니다.

[user@mon ~]$ ceph dashboard feature disable iscsi

이 예제에서는 Ceph iSCSI 게이트웨이 기능을 비활성화합니다.

기능을 활성화합니다.

[user@mon ~]$ ceph dashboard feature enable cephfs

이 예에서는 Ceph Filesystem 기능을 활성화합니다.

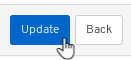

1.4. 대시보드 아키텍처

대시보드 아키텍처는 Ceph 관리자 대시보드 플러그인 및 기타 구성 요소에 따라 다릅니다. 아래 다이어그램을 통해 함께 작동하는 방법을 알아보십시오.

2장. Ceph 대시보드 설치 및 액세스

시스템 관리자는 대시보드를 설치하고 처음으로 액세스할 수 있습니다.

Red Hat Ceph Storage는 Cockpit 웹 인터페이스를 사용하거나 ceph-ansible RPM에서 제공하는 Ansible 플레이북을 사용하여 명령줄에서 그래픽으로 설치됩니다. Cockpit에서는 동일한 Ansible 플레이북을 사용하여 Ceph를 설치합니다. 이러한 플레이북은 기본적으로 대시보드를 설치합니다. 따라서 Ansible 플레이북을 직접 사용하거나 Cockpit을 사용하여 Ceph를 설치하든 대시보드가 설치됩니다.

기본 대시보드 암호를 변경합니다. 기본적으로 대시보드의 암호는 안전하지 않은 p@ssw0rd 입니다. 플레이북을 Ceph를 설치하기 전에 또는 동일한 플레이북 또는 대시보드 자체를 사용하여 설치한 후 all.yml Ansible 플레이북에서 dashboard_admin_password 를 업데이트하여 Ceph를 설치하기 전에 기본 암호를 변경할 수 있습니다. 자세한 내용은 설치 가이드, 대시보드를 사용하여 대시보드 암호 변경 또는 Ansible을 사용하여 대시보드 암호 변경을 참조하십시오.

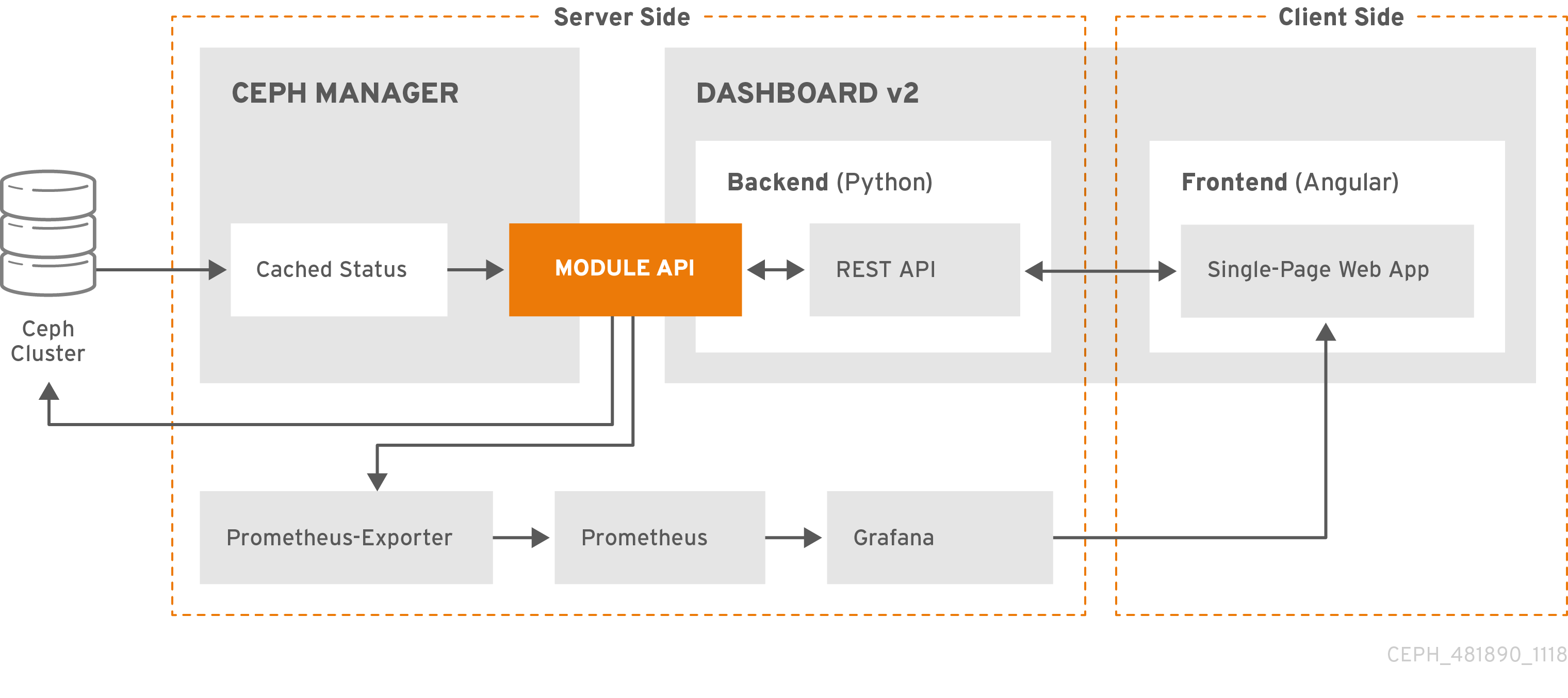

2.1. Cockpit을 사용하여 대시보드 설치

Cockpit 웹 인터페이스를 사용하여 Red Hat Ceph Storage를 설치하는 경우 대시보드가 기본적으로 설치됩니다. Grafana가 설치되도록 Metrics 역할이 있는 호스트를 설정해야 합니다.

사전 요구 사항

- 전체 사전 요구 사항은 설치 가이드 를 참조하십시오. 이 절차에서는 대시보드 설치와 관련된 단계만 강조 표시합니다.

절차

Hosts 페이지에서 호스트를 추가하고 Metrics 역할을 설정합니다.

- 추가를 클릭합니다.

- 나머지 Cockpit Ceph 설치 프로그램 프롬프트를 완료합니다.

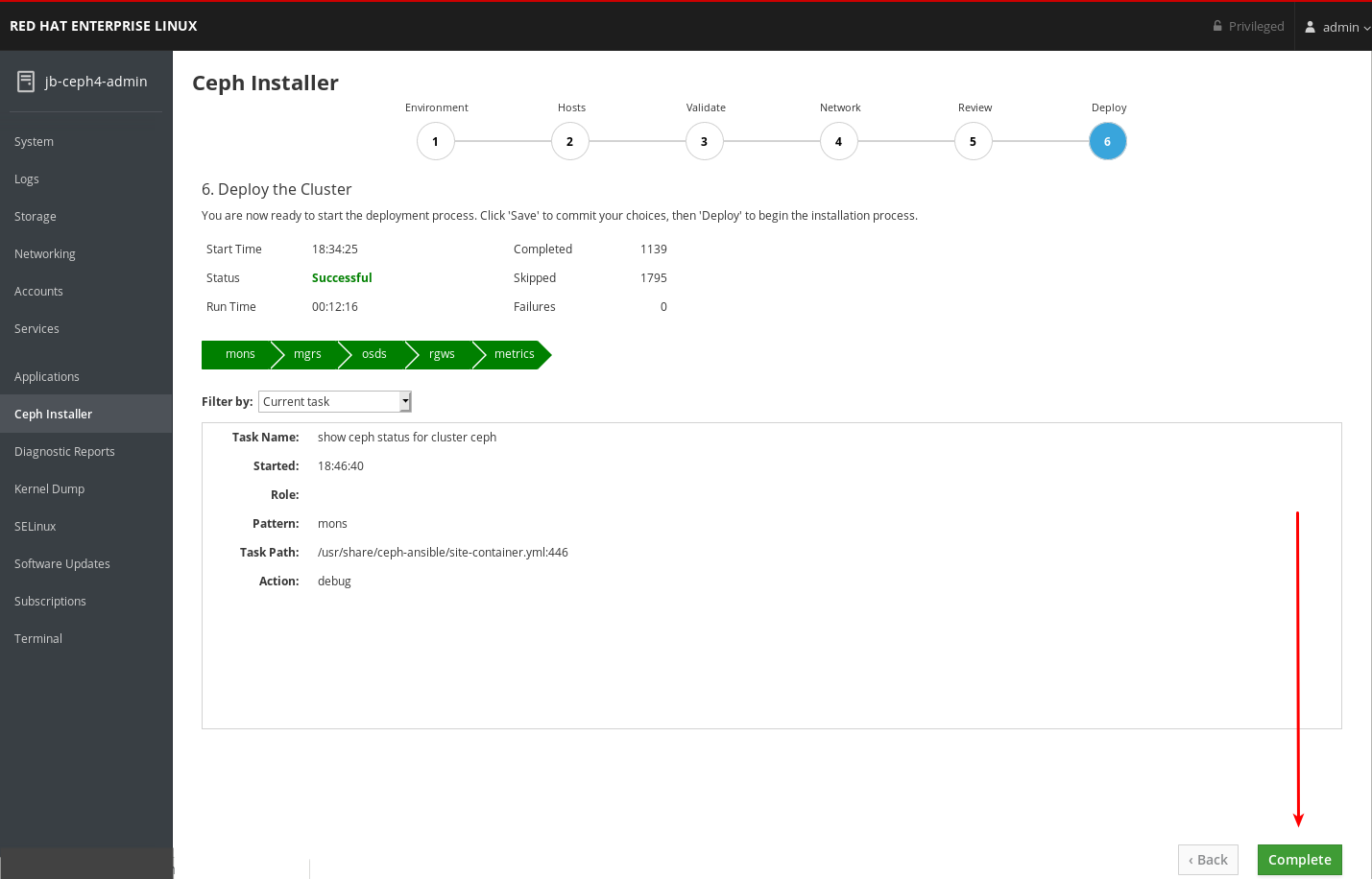

배포 프로세스가 완료되면 페이지 오른쪽 하단에 있는 완료 버튼을 클릭합니다. 그러면

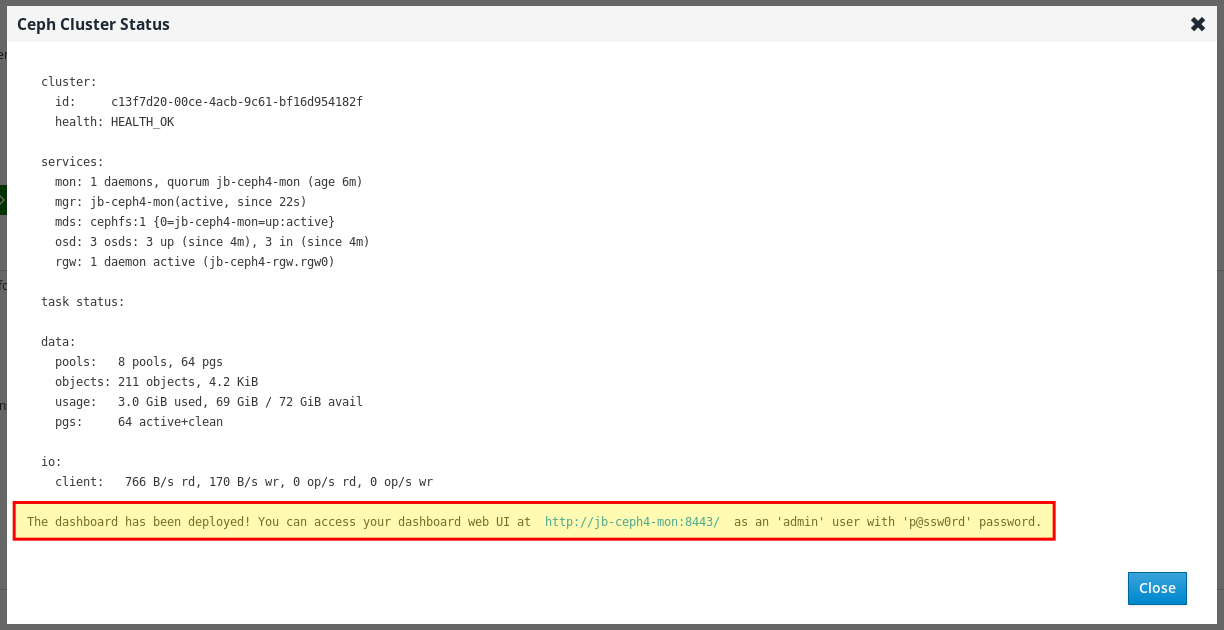

ceph status명령 출력 및 대시보드 액세스 정보가 표시되는 창이 열립니다.

Ceph 클러스터 상태 창 하단에 URL, 사용자 이름, 암호를 포함하여 대시보드 액세스 정보가 표시됩니다. 이 정보를 기록해 둡니다.

2.2. Ansible을 사용하여 대시보드 설치

ceph-ansible RPM에서 제공하는 Ansible 플레이북을 사용하여 Red Hat Ceph Storage를 설치할 때 대시보드는 기본적으로 설치됩니다.

사전 요구 사항

- 전체 사전 요구 사항은 설치 가이드 를 참조하십시오. 이 절차에서는 대시보드 설치와 관련된 단계만 강조 표시합니다.

절차

아래에 정의된 노드가 있는

[grafana-server]그룹이 Ansible 인벤토리 파일에 있는지 확인합니다. Grafana 및 Prometheus가 이 노드에 설치됩니다.[root@jb-ceph4-admin ~]# grep grafana-server -A 1 /etc/ansible/hosts [grafana-server] jb-ceph4-mon

all.ymlAnsible 플레이북에서dashboard_enabled:가False로 설정되지 않았는지 확인합니다. 기본 설정을 나타내는 주석이True여야 합니다.[root@jb-ceph4-admin ~]# grep "dashboard_enabled" /usr/share/ceph-ansible/group_vars/all.yml #dashboard_enabled: True

- 설치 가이드에 설명된 대로 Ceph를 설치하는 데 필요한 나머지 단계를 완료합니다.

베어 메탈 설치용

ansible-playbook site.yml을 실행하거나 컨테이너 설치용ansible-playbook site-docker.yml을 실행하면 Ansible에서 대시보드 액세스 정보를 출력합니다. 플레이북 출력 끝에 있는 대시보드 URL, 사용자 이름 및 암호를 찾습니다.2019-12-13 15:31:17,871 p=11421 u=admin | TASK [ceph-dashboard : print dashboard URL] ************************************************************ 2019-12-13 15:31:17,871 p=11421 u=admin | task path: /usr/share/ceph-ansible/roles/ceph-dashboard/tasks/main.yml:5 2019-12-13 15:31:17,871 p=11421 u=admin | Friday 13 December 2019 15:31:17 -0500 (0:00:02.189) 0:04:25.380 ******* 2019-12-13 15:31:17,934 p=11421 u=admin | ok: [jb-ceph4-mon] => msg: The dashboard has been deployed! You can access your dashboard web UI at http://jb-ceph4-mon:8443/ as an 'admin' user with 'p@ssw0rd' password.

출력을 기록하십시오.

http://jb-ceph4-mon:8443/ 에서 'p@ssw0rd' 암호를 사용하는 'admin' 사용자로 대시보드 웹 UI에 액세스할 수 있습니다.

Ansible 플레이북에서는 다음을 수행합니다.

-

ceph-mgr에서 Prometheus 모듈을 활성화합니다. -

ceph-mgr에서 dashboard 모듈을 활성화하고 TCP 포트 8443을 엽니다. 스토리지 클러스터의 각 노드에 Prometheus

node_exporter데몬을 배포합니다.- TCP 포트 9100을 엽니다.

-

node_exporter데몬을 시작합니다.

Ansible 인벤토리 파일의

[grafana-server]아래에 있는 노드에 Docker/systemd에 Grafana 및 Prometheus 컨테이너를 배포합니다.- 각 Ceph 호스트에서 실행되는 ceph-mgr 노드 및 node-exporters에서 데이터를 수집하도록 Prometheus를 구성합니다.

- TCP 포트 3000을 엽니다.

- Grafana에서 대시보드, 주제 및 사용자 계정을 만듭니다.

- Ceph 대시보드 로그인 페이지 URL을 표시합니다.

2.3. 네트워크 포트 요구 사항

Ceph 대시보드 구성 요소는 액세스할 수 있어야 하는 특정 TCP 네트워크 포트를 사용합니다. 기본적으로 네트워크 포트는 Red Hat Ceph Storage를 설치하는 동안 firewalld 에서 자동으로 열립니다.

표 2.1. TCP 포트 요구 사항

| 포트 | 사용 | 원래 노드 | 대상 노드 |

|---|---|---|---|

| 8443 | 대시보드 웹 인터페이스 |

AlertManager 서비스는 경고를 보고하기 위해 대시보드에 대한 연결을 시작할 수 있으므로 Ansible 인벤토리 파일의 | Ceph Manager 노드. |

| 3000 | Grafana |

Grafana 대시보드 UI 및 모든 Ceph Manager 호스트 및 |

Ansible 인벤토리 파일의 |

| 9090 | 기본 Prometheus 그래프용 기본 Prometheus 서버 |

Prometheus UI 및 모든 Ceph Manager 호스트 및 |

Ansible 인벤토리 파일의 |

| 9092 | 기본 Prometheus 그래프용 Prometheus 서버 |

Prometheus UI 및 모든 Ceph Manager 호스트 및 |

Ansible 인벤토리 파일의 |

| 9093 | Prometheus Alertmanager |

Alertmanager Web UI 및 모든 Ceph Manager 호스트 및 Prometheus를 실행하는 |

Ansible 인벤토리 파일의 모든 Ceph Manager 노드와 |

| 9094 | 여러 인스턴스에서 만든 고가용성 클러스터 구성을 위한 Prometheus Alertmanager |

Ansible 인벤토리 파일의 모든 Ceph Manager 노드와 |

Prometheus Alertmanager High Availability(peer 데몬 동기화) |

| 9100 |

Prometheus |

Node Exporter 지표 웹 UI 및 모든 Ceph Manager 노드 및 Prometheus를 실행하는 |

MON, OSDS, |

| 9283 | Ceph Manager Prometheus exporter 모듈 |

Ceph Exporter 지표 웹 UI 및 | 모든 Ceph Manager 노드. |

| 9287 | Ceph iSCSI 게이트웨이 데이터 |

모든 Ceph Manager 호스트 및 | 모든 Ceph iSCSI 게이트웨이 노드. |

추가 리소스

- 자세한 내용은 Red Hat Ceph Storage 설치 가이드를 참조하십시오.

- 자세한 내용은 네트워킹 구성 및 관리에서 방화벽 사용 및 구성을 참조하십시오.

2.4. 대시보드 포트 구성

Red Hat Ceph Storage 대시보드는 기본적으로 TCP/IP 주소 및 TCP 포트에 바인딩됩니다.

기본적으로 SSL이 비활성화되면 대시보드를 호스팅하는 ceph-mgr 데몬이 TCP 포트 8443 또는 8080에 바인딩됩니다. 특정 주소가 구성되지 않은 경우 웹 앱은 사용 가능한 모든 IP4 및 IP6 주소에 해당하는 :: 에 바인딩됩니다.

클러스터 수준의 구성 키 기능을 사용하여 IP 주소 및 포트를 변경할 수 있습니다.

사전 요구 사항

- Red Hat Ceph Storage 클러스터.

- Red Hat Ceph Storage 대시보드 설치.

- 모든 노드에 대한 루트 수준 액세스.

절차

대시보드에 액세스할 URL을 가져옵니다.

예제

[root@admin ~]# ceph mgr services

ceph-mgr데몬의 현재 IP 및 포트 구성을 가져옵니다.예제

[root@admin ~]# netstat -ntlp

IP 주소와 포트를 설정합니다.

구문

ceph config set mgr mgr/dashboard/server_addr IP_ADDRESS ceph config set mgr mgr/dashboard/server_port PORT ceph config set mgr mgr/dashboard/ssl_server_port PORT

예제

[root@mon ~]# ceph config set mgr mgr/dashboard/server_addr 192.168.0.120 [root@mon ~]# ceph config set mgr mgr/dashboard/server_port 8443 [root@mon ~]# ceph config set mgr mgr/dashboard/ssl_server_port 8443

선택 사항:

ceph-mgr은 대시보드의 자체 인스턴스를 호스팅하므로 별도로 구성할 수 있습니다. 특정 관리자 인스턴스의 IP 주소 및 포트를 변경합니다.구문

ceph config set mgr mgr/dashboard/NAME/server_addr IP_ADDRESS ceph config set mgr mgr/dashboard/NAME/server_port PORT ceph config set mgr mgr/dashboard/NAME/ssl_server_port PORT

Replace:NAME 을 대시보드를 호스팅하는

ceph-mgr인스턴스의 ID로 바꿉니다.예제

[root@mon ~]# ceph config set mgr mgr/dashboard/mgrs-0/server_addr 192.168.0.120 [root@mon ~]# ceph config set mgr mgr/dashboard/mgrs-0/server_port 8443 [root@mon ~]# ceph config set mgr mgr/dashboard/mgrs-0/ssl_server_port 8443

추가 리소스

- 자세한 내용은 Knowledgebase 문서 How to update the IP address or Port of the Ceph-dashboard 에서 참조하십시오.

2.5. 대시보드에 액세스

대시보드에 액세스하면 Red Hat Ceph Storage 클러스터를 관리하고 모니터링할 수 있습니다.

사전 요구 사항

- Red Hat Ceph Storage 대시보드를 성공적으로 설치합니다.

- NTP는 시계를 올바르게 동기화하고 있습니다.

노드가 올바르게 동기화되지 않은 경우 대시보드 노드, 클러스터 노드 및 브라우저 간에 시간 지연이 발생할 수 있습니다. 브라우저 실행 시 모든 노드와 브라우저가 실행되는 시스템에 NTP에서 동기화된 시간이 있는지 확인합니다. 기본적으로 Red Hat Ceph Storage가 배포되면 Ansible은 모든 노드에 NTP를 구성합니다. 확인하려면 Red Hat Enterprise Linux 7의 경우 ntpd를 사용하여 NTP 구성을 참조하십시오. Red Hat Enterprise Linux 8의 경우 Chrony 모음을 사용하여 NTP를 구성 하십시오. 다른 운영 체제에서 브라우저를 실행하는 경우 해당 운영 체제 공급 업체에 NTP 구성 정보를 참조하십시오.

Red Hat Ceph Storage와 함께 OpenStack Platform(OSP)을 사용하여 OSP Safe 모드를 활성화하려면 다음 방법 중 하나를 사용합니다. Ansible을 사용하여 group_vars/all.yml Ansible 플레이북을 편집하고 dashboard_admin_user_ro: true 를 설정하고, 베어 메탈 또는 컨테이너 배포에 대해 site.yml 또는 site-container.yml 에 대해 ansible-playbook 을 다시 실행합니다. ceph 명령을 사용하여 OSP Safe 모드를 활성화하려면 ceph 대시보드 ac-user-set-roles admin 읽기 전용 을 실행합니다. ceph-ansible Ansible 플레이북을 실행하는 경우 변경 사항이 유지되도록 group_vars/all.yml 을 편집하고 dashboard_admin_user_ro: true 를 설정합니다.

절차

웹 브라우저에 다음 URL을 입력합니다.

http://HOST_NAME:PORT

교체:

- 대시보드 노드의 호스트 이름이 있는 HOST_NAME.

포트

8443을 사용하여 PORT예를 들어 다음과 같습니다.

http://dashboard:8443

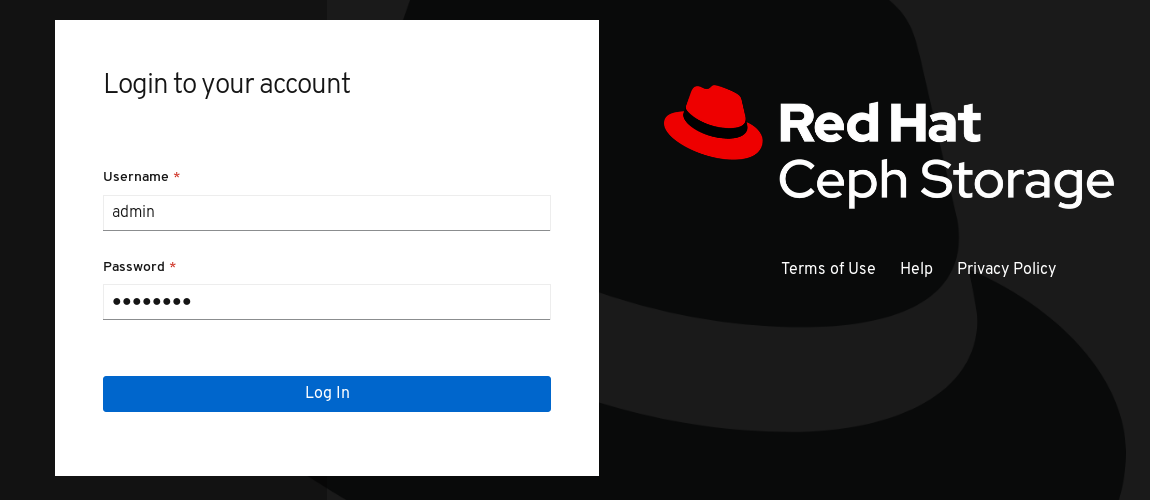

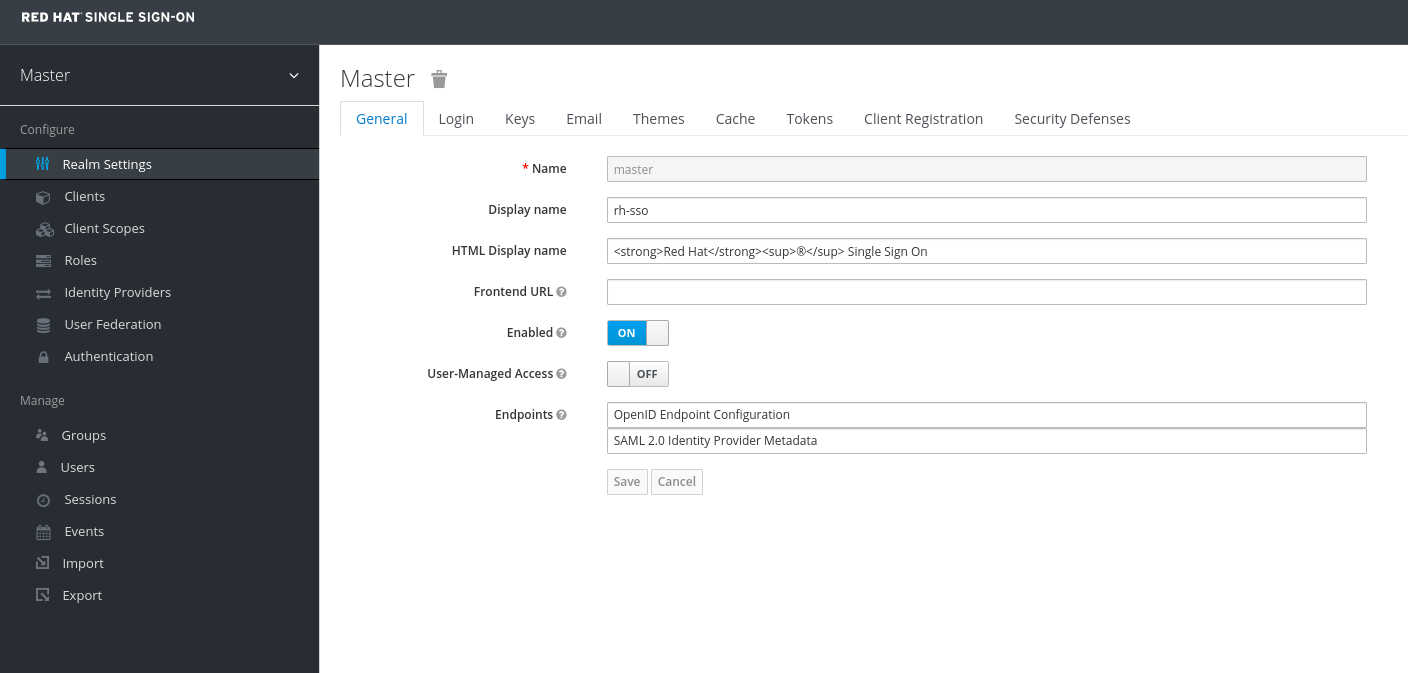

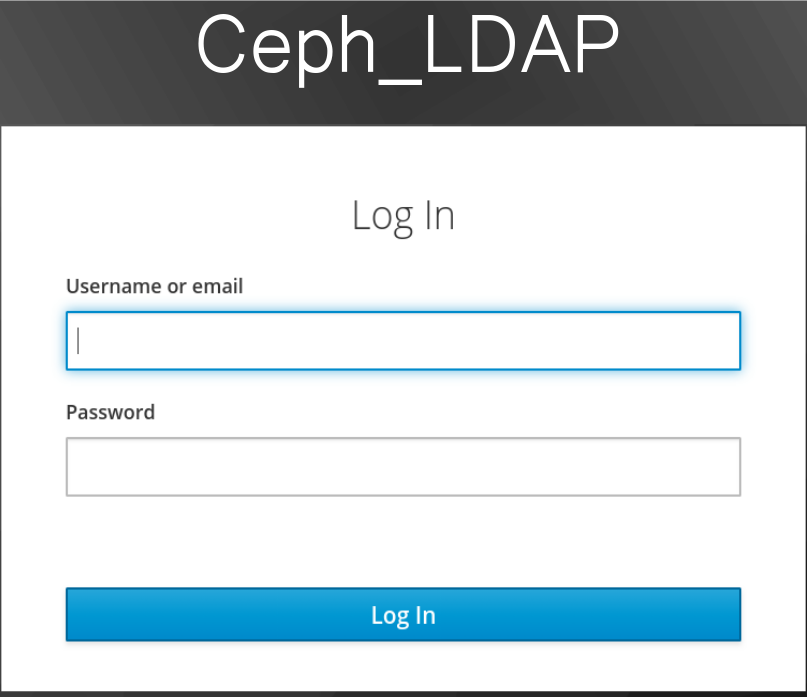

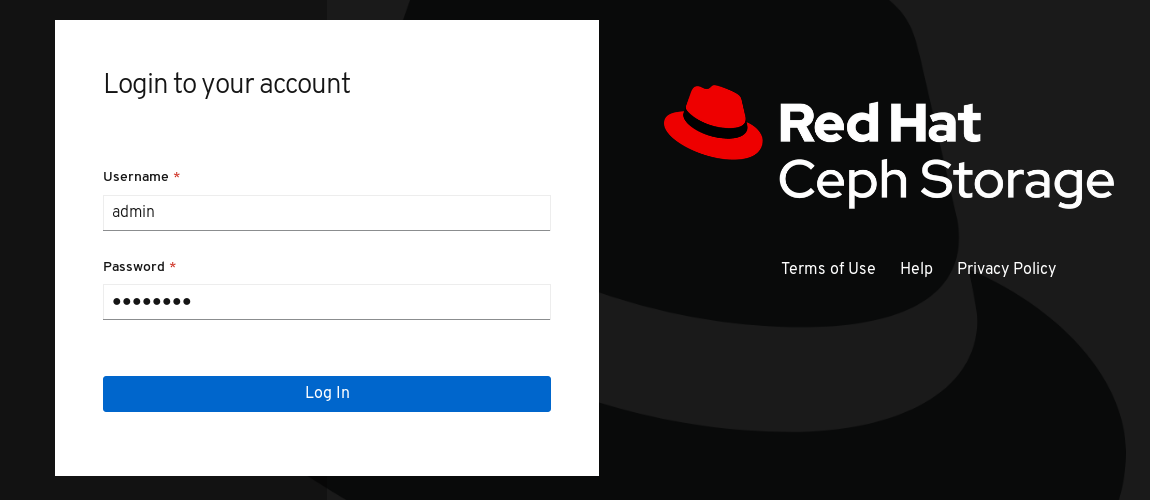

로그인 페이지에서 설치 중에 암호를 변경하지 않은 경우 사용자 이름

admin및 기본 암호p@ssw0rd를 입력합니다.그림 2.1. Ceph 대시보드 로그인 페이지

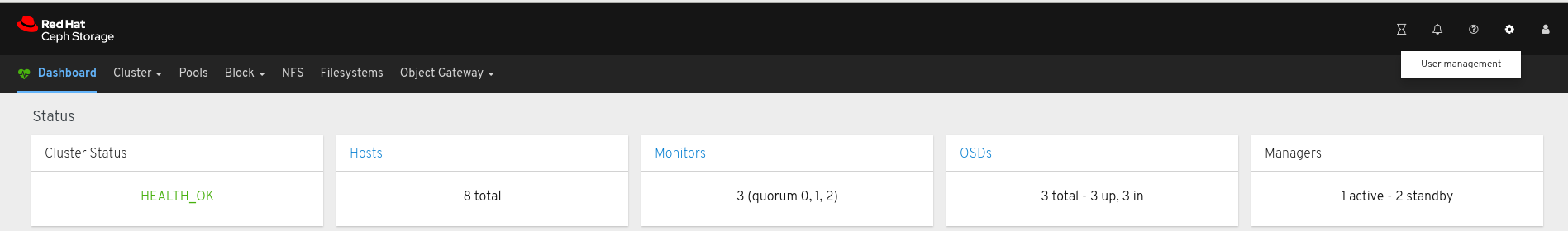

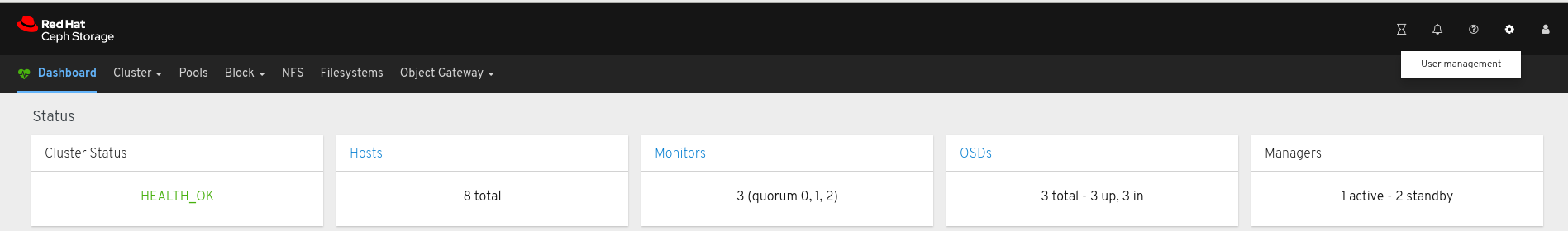

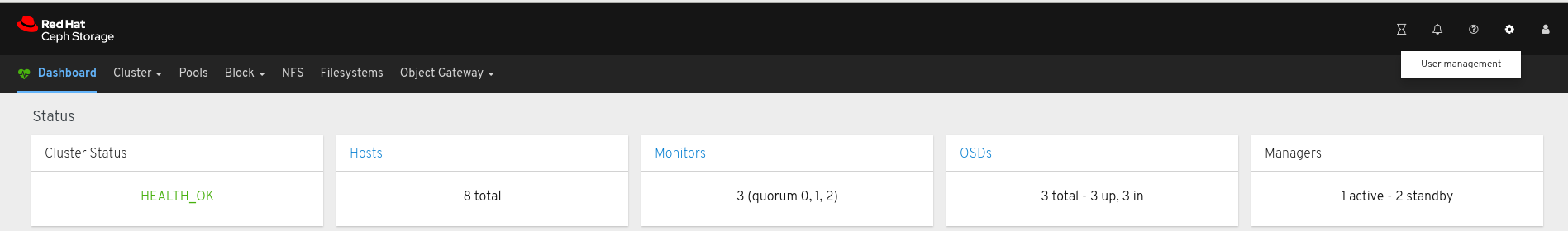

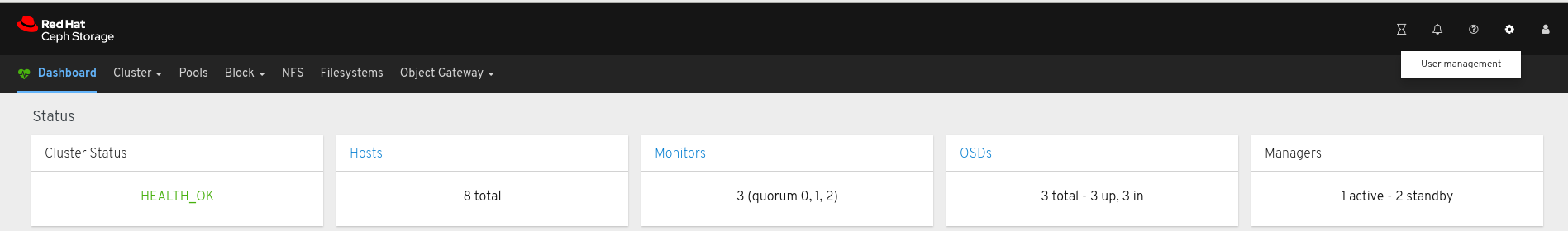

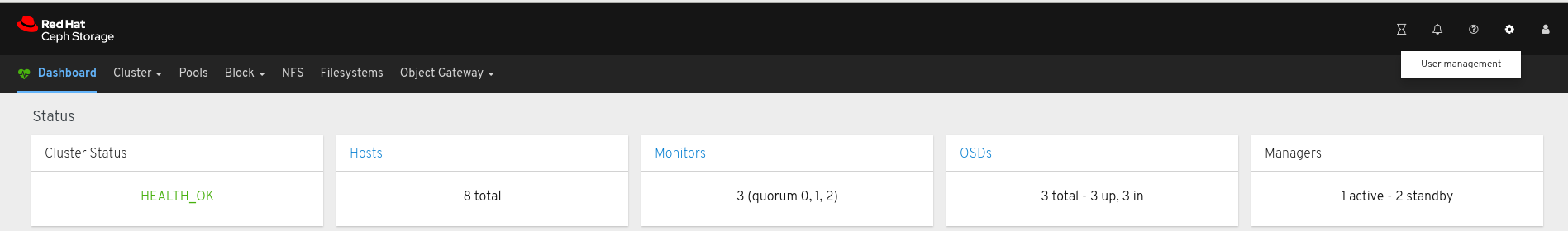

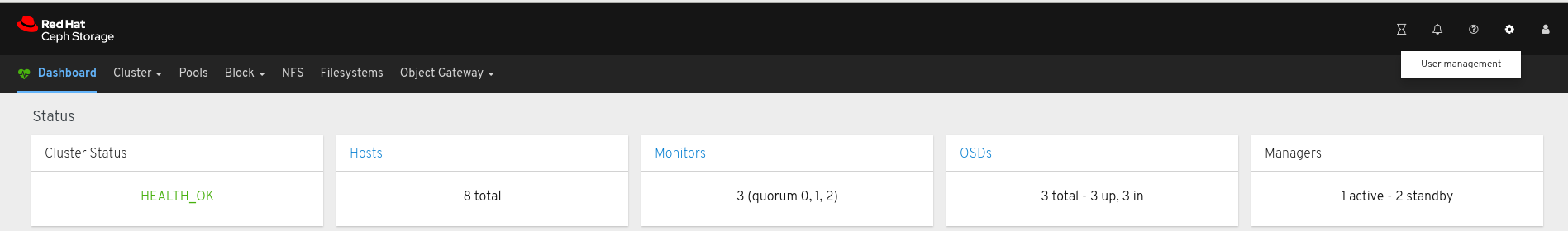

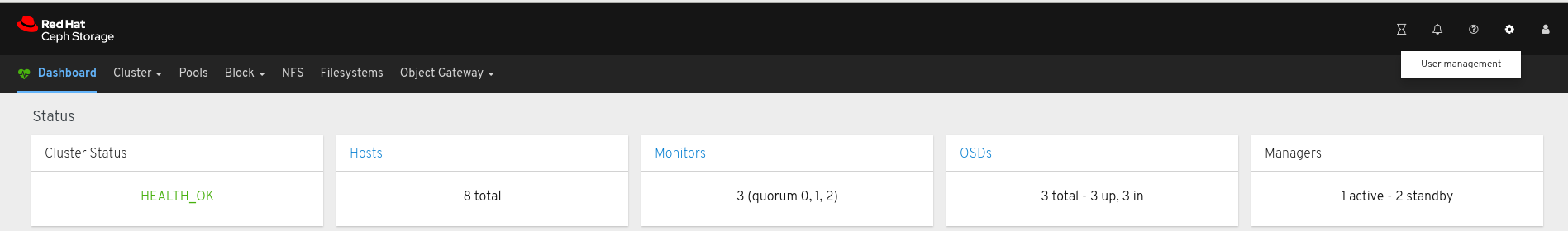

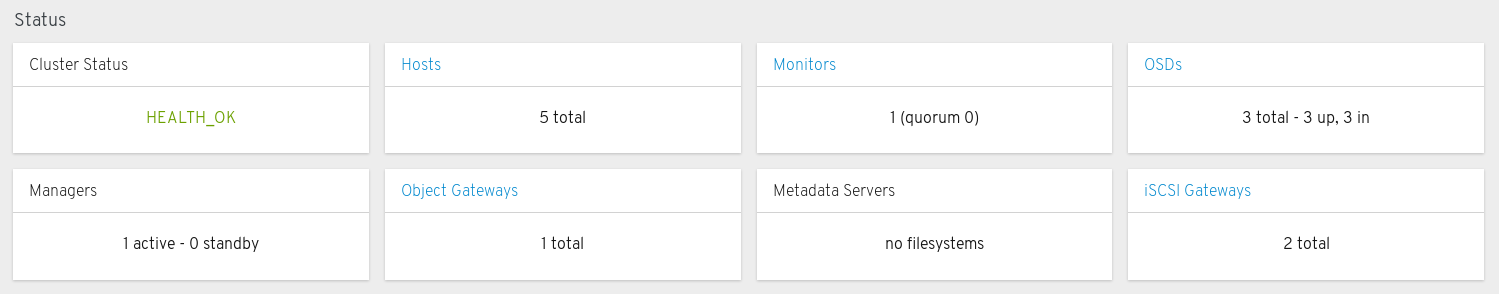

로그인하면 대시보드 기본 시작 페이지가 표시됩니다. 이 페이지는 Red Hat Ceph Storage 클러스터의 상태, 성능 및 용량 지표에 대한 고급 개요를 제공합니다.

그림 2.2. Ceph 대시보드 기본 시작 페이지

추가 리소스

- 자세한 내용은 대시보드 가이드 의 대시보드를 사용하여 대시보드 암호 변경을 참조하십시오.

- 자세한 내용은 대시보드 가이드 의 Ansible을 사용하여 대시보드 암호 변경을 참조하십시오.

2.6. Ansible을 사용하여 대시보드 암호 변경

기본적으로 대시보드에 액세스하는 암호는 p@ssw0rd 로 설정됩니다.

보안상의 이유로 설치 후 암호를 변경합니다.

Ansible을 사용하여 대시보드 암호를 변경할 수 있습니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- Ansible 관리 노드에 대한 액세스.

절차

-

편집을 위해 Ansible 플레이북 파일

/usr/share/ceph-ansible/group_vars/all.yml을 엽니다. 이 행에서 주석을 제거하고 암호를 업데이트합니다.

#dashboard_admin_password: p@ssw0rd

다음으로 변경합니다.

dashboard_admin_password: NEW_PASSWORDNEW_PASSWORD 를 원하는 암호로 바꿉니다.

Ceph 클러스터를 배포하거나 업데이트하는 Ansible 플레이북 파일을 다시 실행합니다.

베어 메탈 설치의 경우

site.yml플레이북을 사용합니다.[admin@admin ceph-ansible]$ ansible-playbook -v site.yml

컨테이너 설치의 경우

site-docker.ymlPlaybook을 사용합니다.[admin@admin ceph-ansible]$ ansible-playbook -v site-docker.yml

- 새 암호를 사용하여 로그인합니다.

추가 리소스

- 자세한 내용은 대시보드 가이드 의 대시보드를 사용하여 대시보드 암호 변경을 참조하십시오.

2.7. 대시보드를 사용하여 대시보드 암호 변경

기본적으로 대시보드에 액세스하는 암호는 p@ssw0rd 로 설정됩니다.

보안상의 이유로 설치 후 암호를 변경합니다.

대시보드를 사용하여 암호를 변경하려면 Ansible에서 Red Hat Ceph Storage 클러스터를 재구성하는 데 사용하는 경우 암호가 기본 암호로 되돌아가지 않도록 Ansible의 대시보드 암호 설정을 변경합니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

절차

Ansible을 Ceph 클러스터를 재구성하는 데 사용할 때 암호가

p@ssw0rd로 재설정되지 않도록group_vars/all.yml파일의 암호를 업데이트합니다.-

편집을 위해 Ansible 플레이북 파일

/usr/share/ceph-ansible/group_vars/all.yml을 엽니다. 이 행에서 주석을 제거하고 암호를 업데이트합니다.

#dashboard_admin_password: p@ssw0rd

다음으로 변경합니다.

dashboard_admin_password: NEW_PASSWORDNEW_PASSWORD 를 원하는 암호로 바꿉니다.

-

편집을 위해 Ansible 플레이북 파일

대시보드 웹 사용자 인터페이스에서 암호를 변경합니다.

대시보드에 로그인합니다.

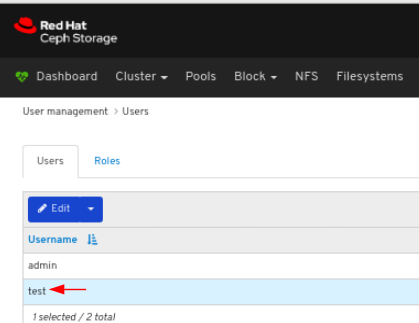

http://HOST_NAME:8443오른쪽 상단에 있는 대시보드 설정 아이콘을 클릭한 다음 사용자 관리 을 클릭합니다.

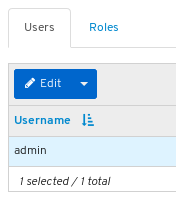

Username 테이블에서

admin사용자를 찾고 admin 을 클릭합니다.

- 사용자 이름 표 위에 있는 편집 버튼을 클릭합니다.

새 암호를 입력하고 Edit User 를 클릭하여 확인합니다.

로그아웃되고 로그인 화면으로 이동합니다. 암호 변경을 확인하는 알림이 표시됩니다.

- 새 암호를 사용하여 다시 로그인합니다.

추가 리소스

- 자세한 내용은 대시보드 가이드 의 Ansible을 사용하여 대시보드 암호 변경을 참조하십시오.

2.8. Ansible을 사용하여 Grafana 암호 변경

기본적으로 대시보드에서 사용되는 Grafana의 암호는 admin 으로 설정됩니다. 이 절차를 사용하여 암호를 변경합니다.

보안상의 이유로 기본값에서 암호를 변경합니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 클러스터의 모든 노드에 대한 root 액세스.

절차

선택 사항: Grafana 컨테이너가 실행 중인 노드를 모르는 경우 Ansible 호스트 파일에서

[grafana-server]아래에 나열된 노드를/etc/ansible/hosts에 있습니다.예제

[grafana-server] grafana

Grafana 컨테이너가 실행 중인 노드에서 암호를 변경합니다.

구문

podman exec CONTAINER_ID grafana-cli admin reset-admin-password --homepath "/usr/share/grafana" NEW_PASSWORD

CONTAINER_ID 를 Grafana 컨테이너의 ID로 변경합니다. NEW_PASSWORD 를 원하는 Grafana 암호로 변경합니다.

예제

[root@grafana ~]# podman exec 3f28b0309aee grafana-cli admin reset-admin-password --homepath "/usr/share/grafana" NewSecurePassword t=2020-10-29T17:45:58+0000 lvl=info msg="Connecting to DB" logger=sqlstore dbtype=sqlite3 t=2020-10-29T17:45:58+0000 lvl=info msg="Starting DB migration" logger=migrator Admin password changed successfully ✔

Ansible 관리 노드에서

ansible-vault를 사용하여 Grafana 암호를 암호화한 다음 암호화된 암호를group_vars/all.yml에 추가합니다./usr/share/ceph-ansible/디렉터리로 변경합니다.[admin@admin ~]$ cd /usr/share/ceph-ansible/

ansible-vault를 실행하고 새 vault 암호를 생성합니다.예제

[admin@admin ceph-ansible]$ ansible-vault encrypt_string --stdin-name 'grafana_admin_password_vault' New Vault password:

암호를 다시 입력하여 확인합니다.

예제

[admin@admin ceph-ansible]$ ansible-vault encrypt_string --stdin-name 'grafana_admin_password_vault' New Vault password: Confirm New Vault password:

Grafana 암호를 입력하고 enter를 누른 다음 CTRL+D를 입력하여 항목을 완료합니다.

구문

ansible-vault encrypt_string --stdin-name 'grafana_admin_password_vault' New Vault password: Confirm New Vault password: Reading plaintext input from stdin. (ctrl-d to end input) NEW_PASSWORDNEW_PASSWORD 를 이전에 설정한 Grafana 암호로 교체합니다.

예제

[admin@admin ceph-ansible]$ ansible-vault encrypt_string --stdin-name 'grafana_admin_password_vault' New Vault password: Confirm New Vault password: Reading plaintext input from stdin. (ctrl-d to end input) NewSecurePassword

grafana_admin_password_vault: !vault |로 시작하고 다음 단계에서 사용되므로 몇 줄의 숫자로 끝나는 출력을 기록해 두십시오.예제

[admin@admin ceph-ansible]$ ansible-vault encrypt_string --stdin-name 'grafana_admin_password_vault' New Vault password: Confirm New Vault password: Reading plaintext input from stdin. (ctrl-d to end input) NewSecurePassword grafana_admin_password_vault: !vault | $ANSIBLE_VAULT;1.1;AES256 38383639646166656130326666633262643836343930373836376331326437353032376165306234 3161386334616632653530383231316631636462363761660a373338373334663434363865356633 66383963323033303662333765383938353630623433346565363534636434643634336430643438 6134306662646365370a343135316633303830653565633736303466636261326361333766613462 39353365343137323163343937636464663534383234326531666139376561663532 Encryption successfulgroup_vars/all.yml을 편집하도록 를 열고 위의 출력을 파일에 붙여넣습니다.예제

grafana_admin_password_vault: !vault | $ANSIBLE_VAULT;1.1;AES256 38383639646166656130326666633262643836343930373836376331326437353032376165306234 3161386334616632653530383231316631636462363761660a373338373334663434363865356633 66383963323033303662333765383938353630623433346565363534636434643634336430643438 6134306662646365370a343135316633303830653565633736303466636261326361333766613462 39353365343137323163343937636464663534383234326531666139376561663532암호화된 암호 아래에 다음과 같이 행을 추가합니다.

예제

grafana_admin_password: "{{ grafana_admin_password_vault }}"참고위에 표시된 대로 자격 증명 모음 값을 Ansible 변수에 직접 할당할 때 문자열 유형을 중단하는 Ansible의 버그 로 인해 두 변수를 사용해야 합니다.

- 파일을 저장한 후 닫습니다.

ansible-playbook을 다시 실행합니다.컨테이너 기반 배포의 경우:

예제

[admin@node1 ceph-ansible]$ ansible-playbook --ask-vault-pass -v site-container.yml -i hosts

-i 호스트는/etc/ansible/hosts의 기본 Ansible 호스트 파일 위치를 사용하지 않는 경우에만 필요합니다.베어 메탈의 경우 RPM 기반 배포의 경우:

예제

[admin@node1 ceph-ansible]$ ansible-playbook --ask-vault-pass -v site.yml -i hosts

-i 호스트는/etc/ansible/hosts의 기본 Ansible 호스트 파일 위치를 사용하지 않는 경우에만 필요합니다.

2.9. 대시보드용 Red Hat Single Sign-On을 사용하여 사용자 동기화

관리자는 LDAP(Lightweight Directory Access Protocol) 통합을 통해 Red Hat SSO(Single Sign-On)를 사용하여 Red Hat Ceph Storage 대시보드에서 사용자에게 액세스할 수 있습니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 대시보드가 설치되어 있습니다.

- 대시보드에 대한 관리자 수준 액세스입니다.

- 사용자가 대시보드에 추가됩니다.

- 모든 노드에서 root 수준 액세스.

- Red hat Single Sign-On은 ZIP 파일에서 설치되었습니다. 자세한 내용은 zip 파일에서 Red Hat Single Sign-On 설치를 참조하십시오.

절차

- Red Hat Ceph Storage가 설치된 시스템에서 Red Hat Single Sign-On 7.4.0 Server 를 다운로드합니다.

폴더의 압축을 풉니다.

[root@cephuser]# unzip rhsso-7.4.0.zip

독립 실행형/구성디렉터리로 이동하여 편집할standalone.xml을 엽니다.[root@cephuser]# cd standalone/configuration [root@cephuser configuration]# vi standalone.xml

-

localhost인스턴스와127.0.0.1의 두 개의 인스턴스를 Red Hat Single Sign-On이 설치된 시스템의 IP 주소로 바꿉니다. 선택 사항: Red Hat Enterprise Linux 8의 경우 사용자는 CA(인증 기관) 문제를 받을 수 있습니다. CA에서 사용자 정의 인증서를 가져와서 정확한 java 버전이 있는 키 저장소로 이동합니다.

예제

[root@cephuser]# keytool -import -noprompt -trustcacerts -alias ca -file ../ca.cer -keystore /etc/java/java-1.8.0-openjdk/java-1.8.0-openjdk-1.8.0.272.b10-3.el8_3.x86_64/lib/security/cacert

rh-sso-7.4폴더의bin디렉터리에서 서버를 시작하려면독립 실행형부팅 스크립트를 실행합니다.[root@cephuser bin]# ./standalone.sh

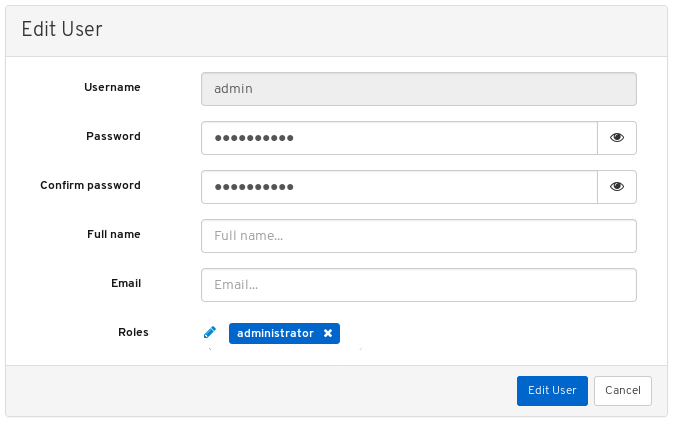

사용자 이름과 암호를 사용하여 http:_IP_ADDRESS_:8080/auth에 admin 계정을 만듭니다.

참고

참고admin 계정은 콘솔에 처음 로그인할 때만 생성해야 합니다.

인증 정보가 생성되어 있는 관리 콘솔에 로그인합니다.

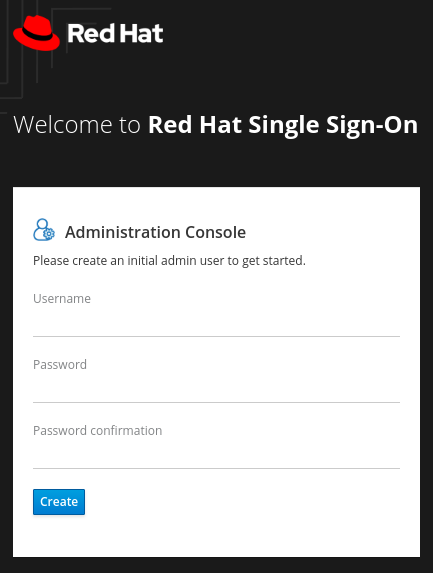

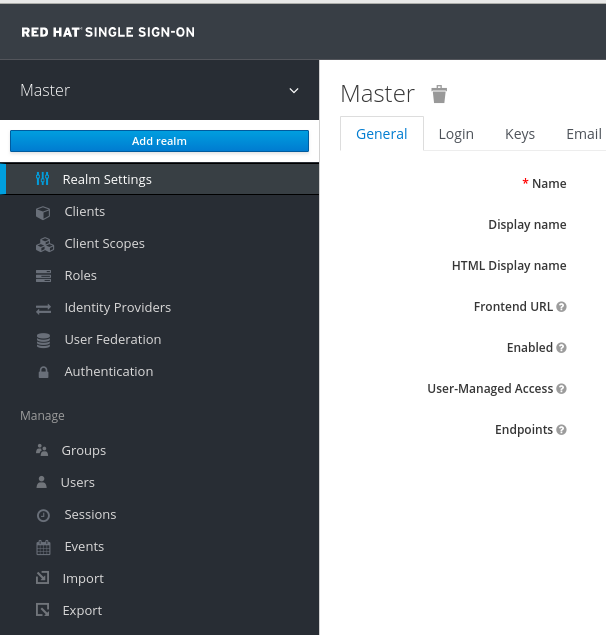

영역을 생성하려면 마스터 드롭다운을 클릭합니다. 이 영역에서 관리자는 사용자 및 애플리케이션에 대한 액세스를 제공합니다.

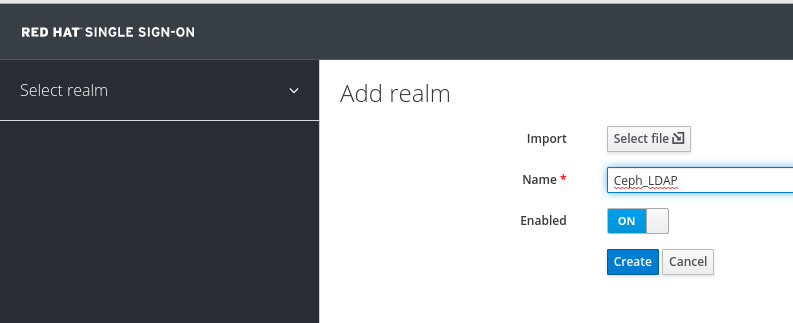

Add realm 창에서 영역의 이름을 입력하고 Enabled (활성화됨) 매개 변수를 ON으로 설정하고 Create를 클릭합니다.

참고

참고영역 이름은 대소문자를 구분합니다.

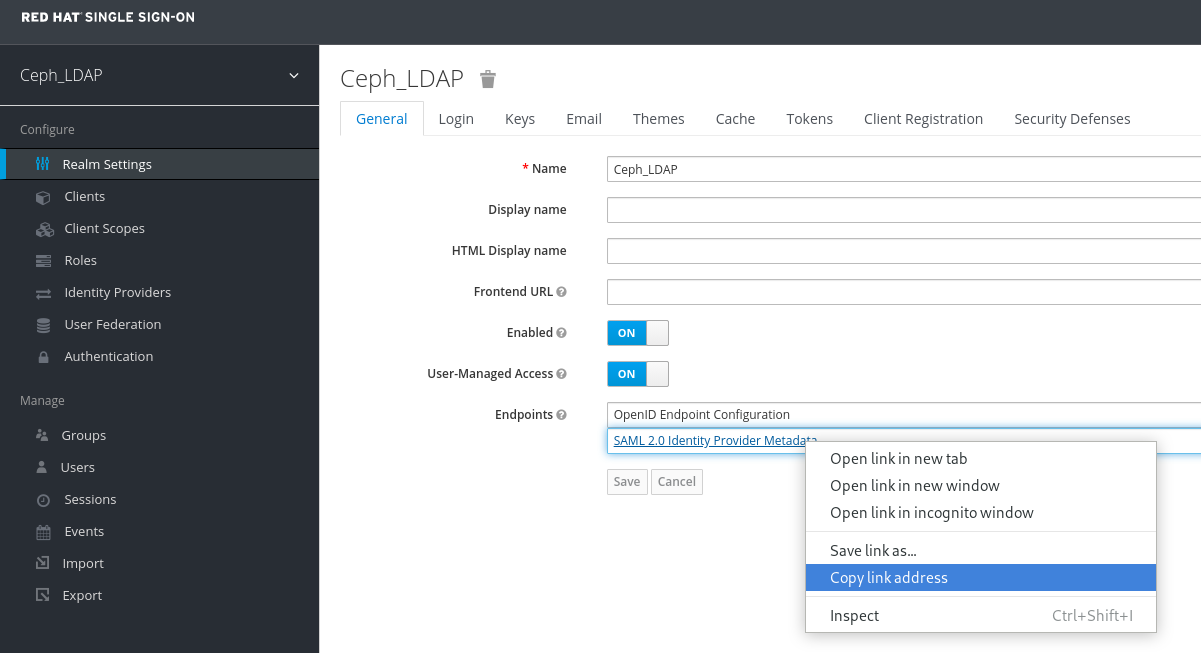

realm Settings 탭에서 다음 매개 변수를 설정하고 저장을 클릭합니다.

- 사용됨 - ON

- 사용자 관리 액세스 - 사용자 관리 액세스

SAML 2.0 ID 공급자 메타데이터의 링크 주소 복사

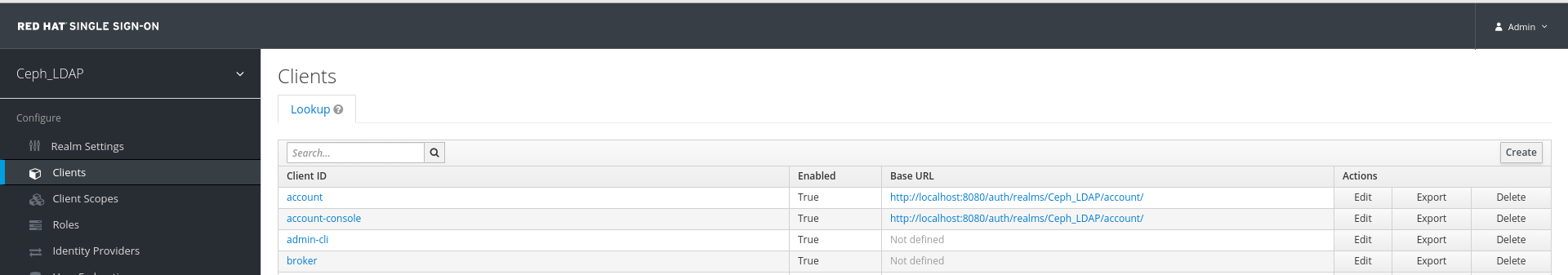

클라이언트 탭에서 생성을 클릭합니다.

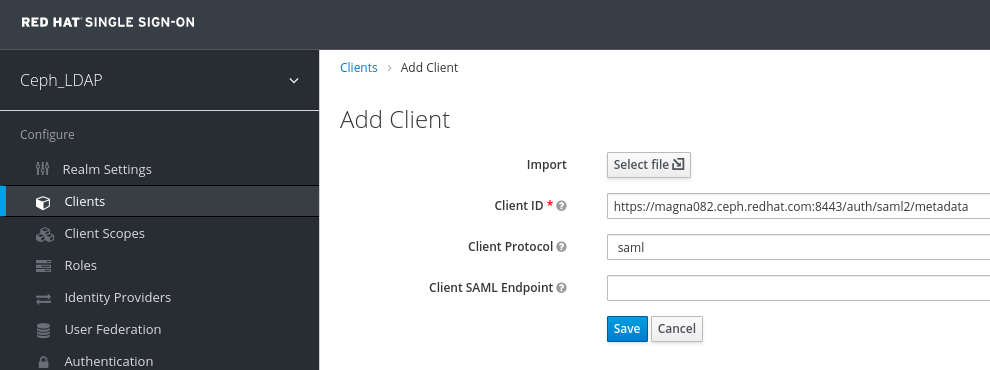

클라이언트 추가 창에서 다음 매개 변수를 설정하고 저장을 클릭합니다.In the Add Client window, set the following parameters and click Save:

Client ID - BASE_URL:8443/auth/saml2/metadata

예제

https://magna082.ceph.redhat.com:8443/auth/saml2/metadata

클라이언트 프로토콜 - saml

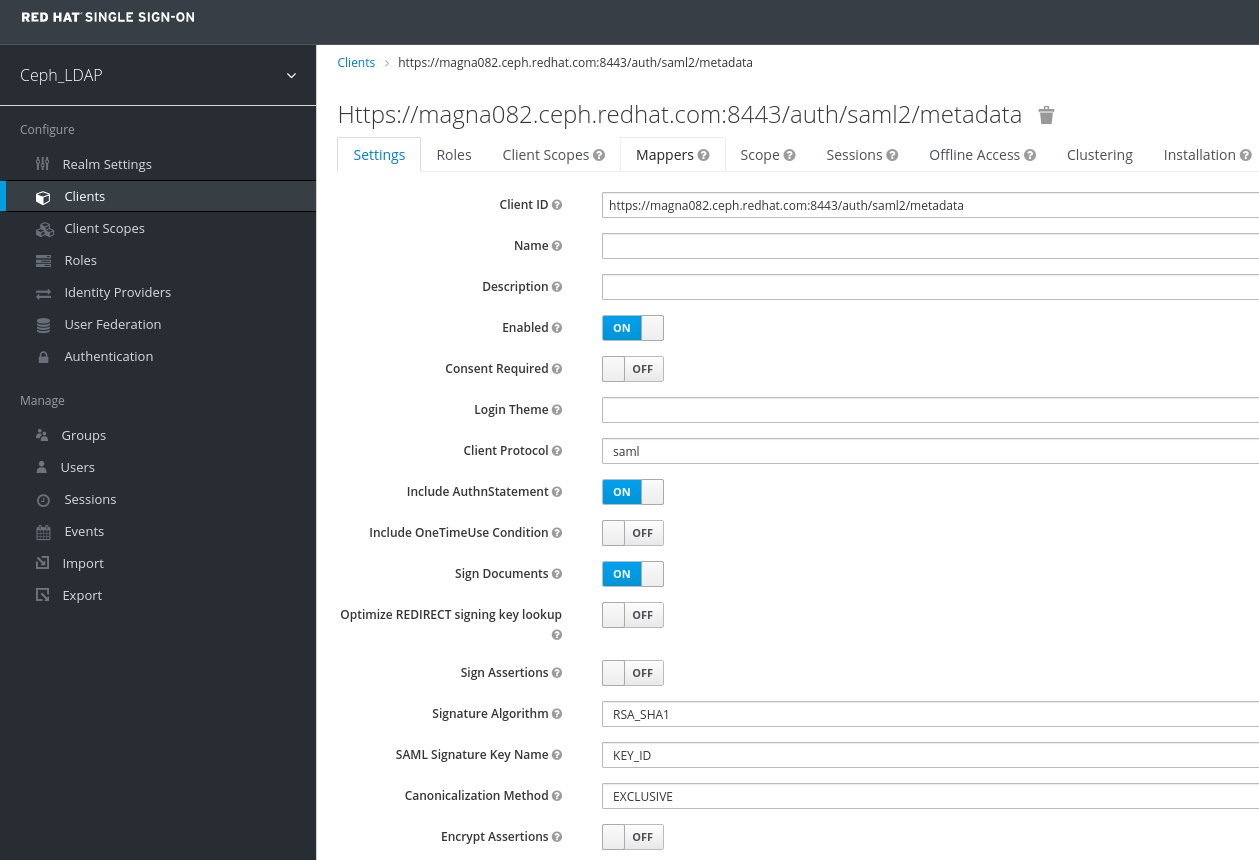

클라이언트 창의 설정 탭에서 다음 매개변수를 설정하고 저장을 클릭합니다.

Client ID - BASE_URL:8443/auth/saml2/metadata

예제

https://magna082.ceph.redhat.com:8443/auth/saml2/metadata

- 사용됨 - ON

- 클라이언트 프로토콜 - saml

- AuthnStatement 포함 - ON

- 로그인 문서 - ON

- 서명 알고리즘 - RSA_SHA1

- SAML 서명 키 이름 - KEY_ID

Valid Redirect URLs - BASE_URL:8443/*

예제

https://magna082.ceph.redhat.com:8443/*

Base URL - BASE_URL:8443

예제

https://magna082.ceph.redhat.com:8443/

마스터 SAML 처리 URL - http://localhost:8080/auth/realms/REALM_NAME/protocol/saml/descriptor

예제

http://localhost:8080/auth/realms/Ceph_LDAP/protocol/saml/descriptor

참고Realm 설정 탭에서 SAML 2.0 ID 공급자 메타데이터 링크를 붙여넣습니다.

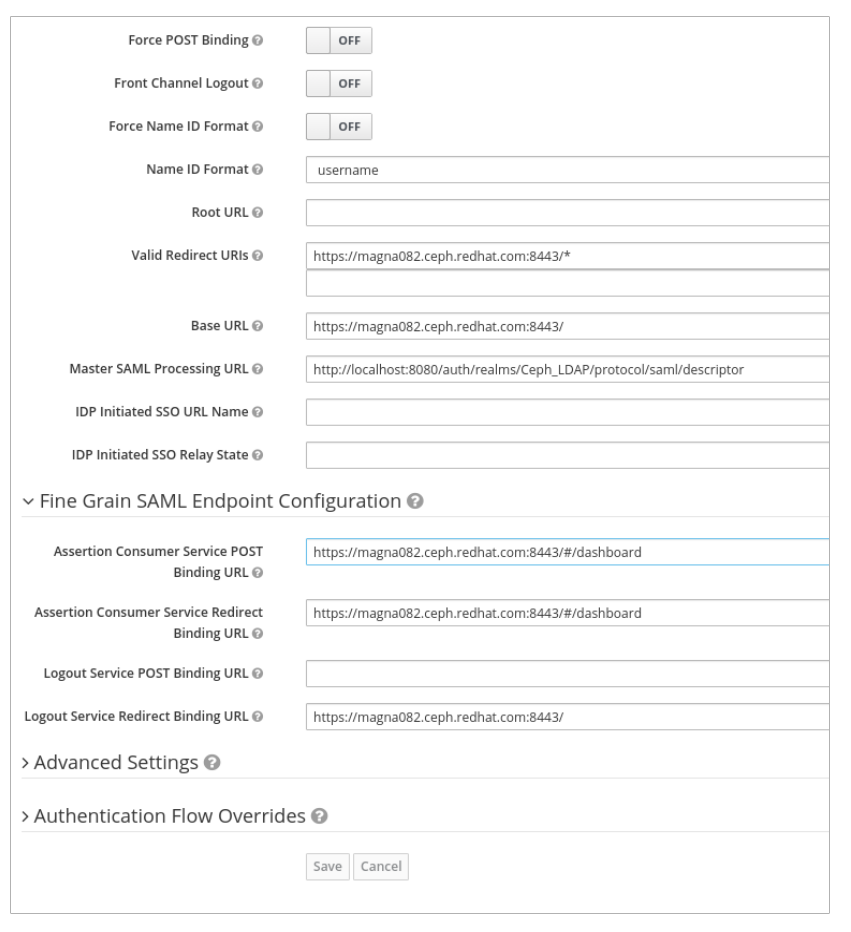

Fine Grain SAML Endpoint Configuration에서 매개변수를 설정합니다.

Assertion Consumer Service POST Binding URL - BASE_URL:8443/#/dashboard

예제

https://magna082.ceph.redhat.com:8443/#/dashboard

Assertion Consumer Service Redirect Binding URL - BASE_URL:8443/#/dashboard

예제

https://magna082.ceph.redhat.com:8443/#/dashboard

Logout Service Redirect Binding URL - BASE_URL:8443/

예제

https://magna082.ceph.redhat.com:8443/

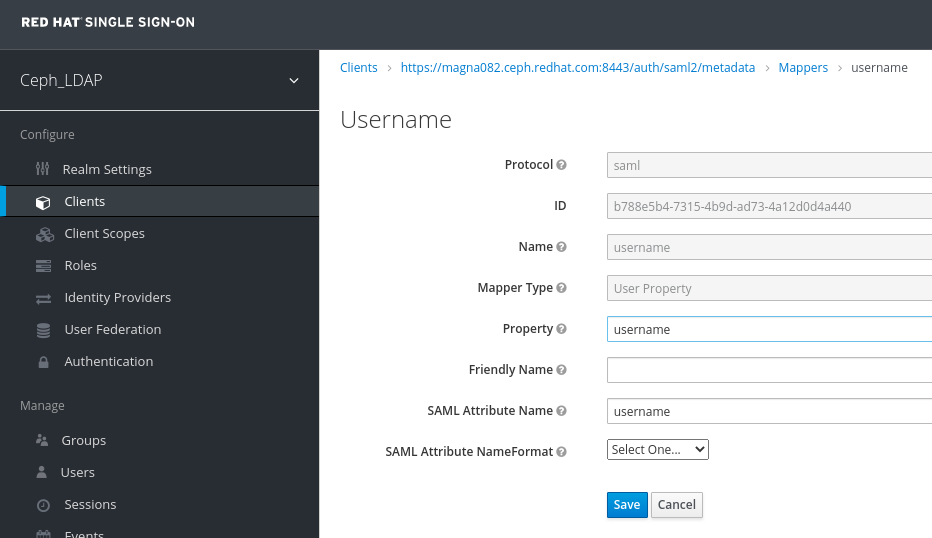

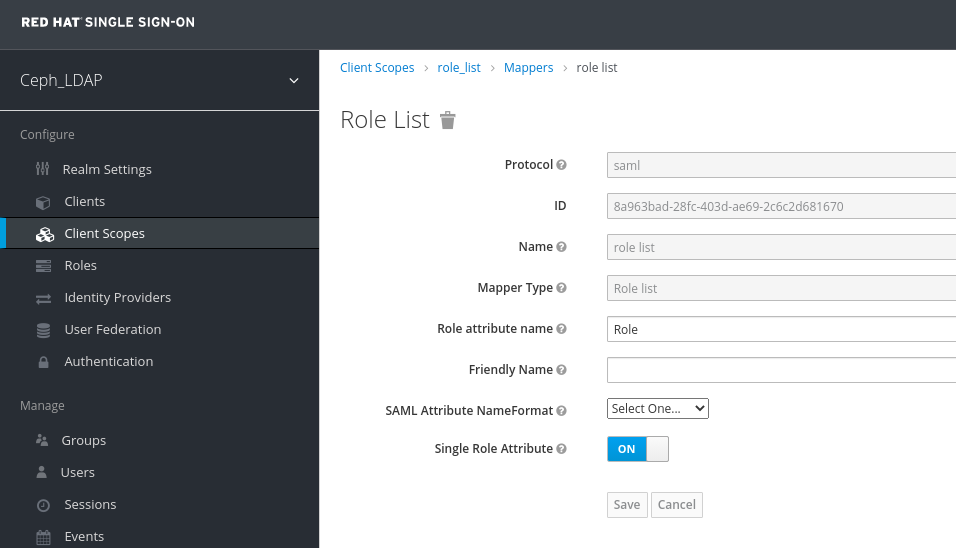

클라이언트 창에서 Mappers 탭을 클릭하고 다음 매개변수를 설정한 후 저장을 클릭합니다.

- 프로토콜 - saml

- 이름 - 사용자 이름

- 매퍼 속성 - 사용자 속성

- 속성 - 사용자 이름

SAML 속성 이름 - 사용자 이름

클라이언트 범위 탭에서 role_list:을 선택합니다.

Mappers 탭에서 역할 목록을 선택하고 Single Role Attribute 를 ON으로 설정합니다.

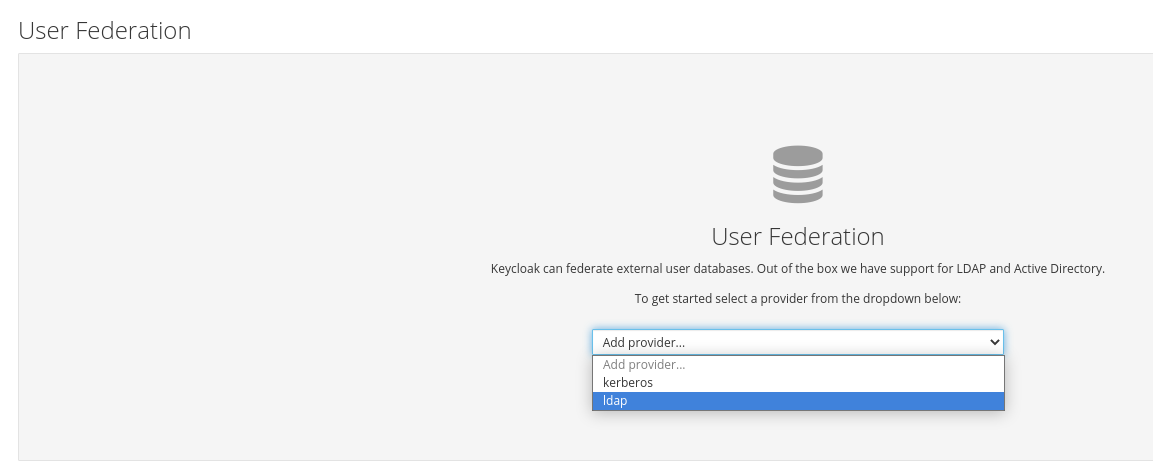

User_Federation 탭을 선택합니다.

사용자 페더레이션 창의 드롭다운에서 ldap 를 선택합니다.

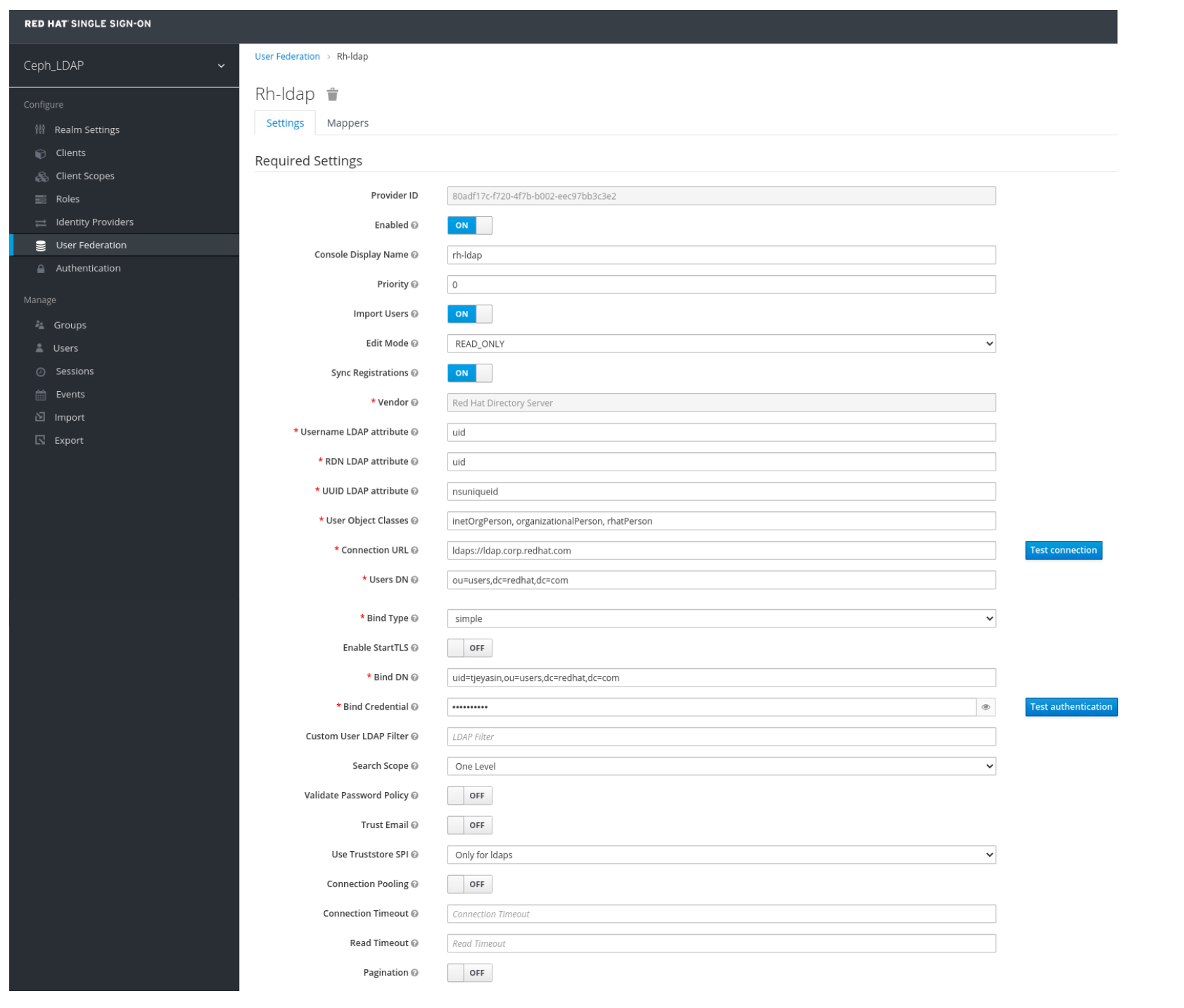

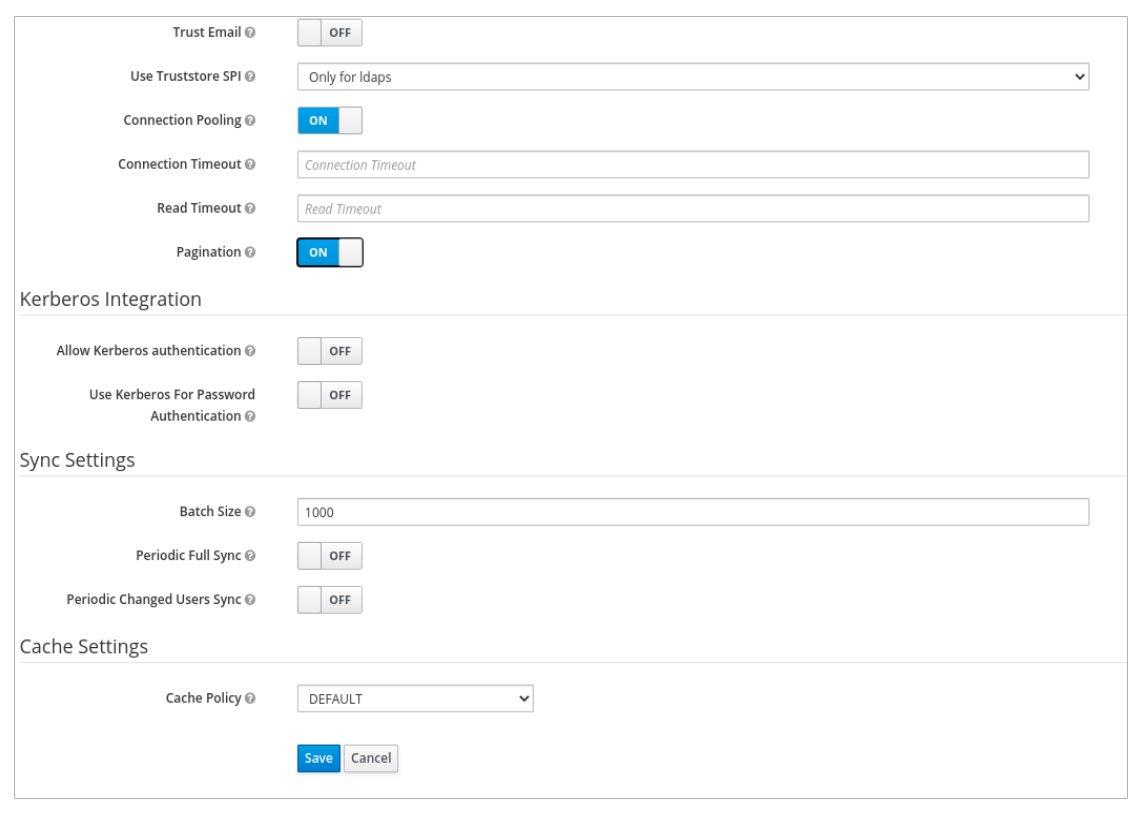

User_Federation 창에서 설정 탭에서 다음 매개변수를 설정하고 저장을 클릭합니다.

- 콘솔 디스플레이 이름 - rh-ldap

- 사용자 가져오기 - ON

- Edit_Mode - READ_ONLY

- 사용자 이름 LDAP 속성 - 사용자 이름

- RDN LDAP 속성 - 사용자 이름

- UUID LDAP 속성 - nsuniqueid

- 사용자 오브젝트 클래스 - inetOrgPerson, organizationalPerson, rhatPerson

연결 URL - ldap:://myldap.example.com

예제

ldap://ldap.corp.redhat.com

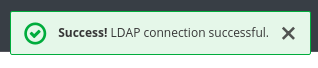

Test Connection (연결 테스트)을 클릭합니다.

LDAP 연결이 성공했음을 알리는 메시지가 표시됩니다.

사용자 DN - ou=users, dc=example, dc=com

예제

ou=users,dc=redhat,dc=com

바인딩 유형 - 단순

테스트 인증 을 클릭합니다.

LDAP 인증이 성공했음을 알리는 메시지가 표시됩니다.

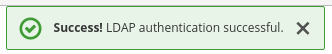

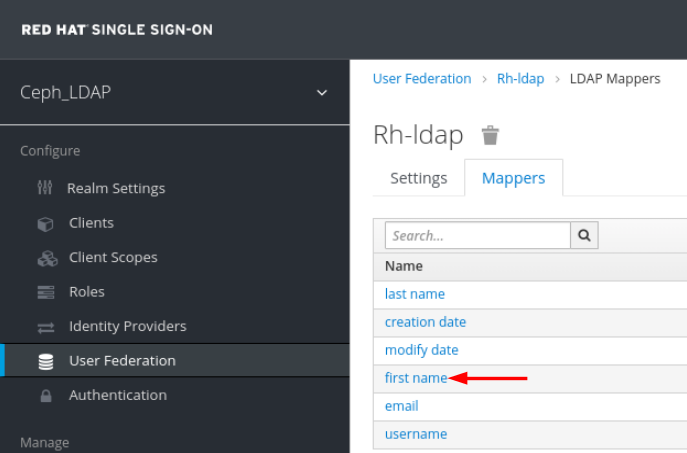

Mappers 탭에서 첫 번째 이름 행을 선택하고 다음 매개변수를 편집하고 저장을 클릭합니다.

LDAP 속성 - givenName

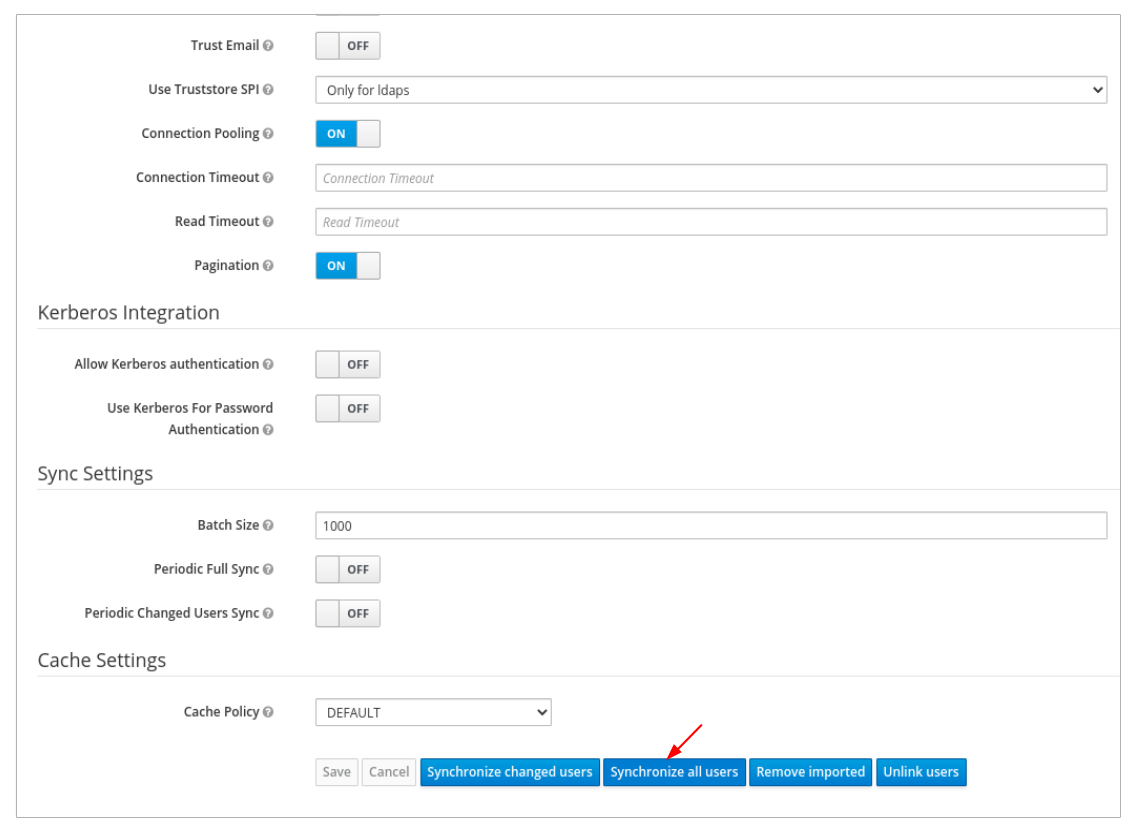

User_Federation 탭에서 설정 탭에서 모든 사용자 동기화 를 클릭합니다.

사용자 동기화가 성공적으로 업데이트된다는 통지를 받습니다.

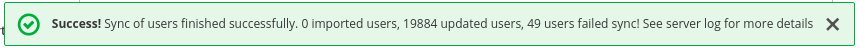

사용자 탭에서 대시보드에 추가된 사용자를 검색하고 검색 아이콘을 클릭합니다.

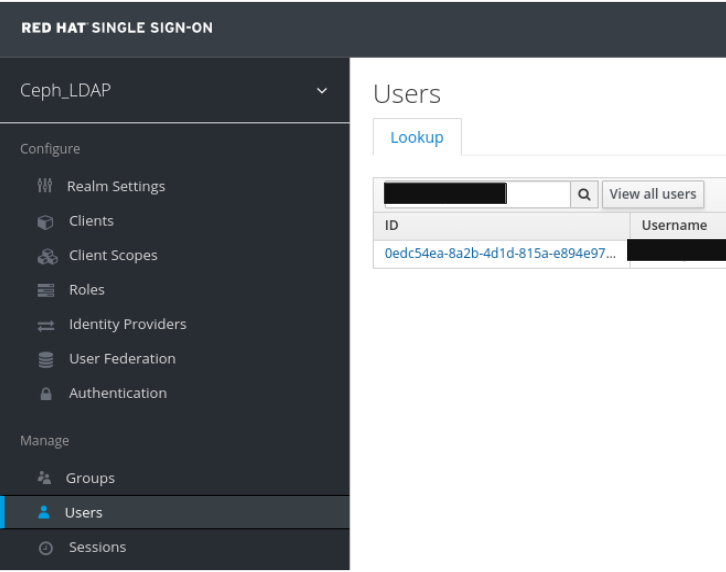

사용자를 보려면 행을 클릭합니다. 페더레이션 링크가 사용자 페더레이션 에 제공된 이름으로 표시되어야 합니다.

중요

중요사용자를 수동으로 추가하지 마십시오. 수동으로 추가한 경우 삭제를 클릭하여 사용자를 삭제합니다.

영역에 추가된 사용자는 메일 주소 및 암호를 사용하여 Ceph 대시보드에 액세스할 수 있습니다.

예제

https://magna082.ceph.redhat.com:8443

추가 리소스

- 대시보드에 사용자를 추가하려면 Red Hat Ceph Storage Dashboard Guide 의 Creating users on dashboard 섹션을 참조하십시오.

- 대시보드에서 사용자 역할을 추가하려면 Red Hat Ceph Storage Dashboard Guide 의 Creating roles on dashboard 섹션을 참조하십시오.

2.10. Ceph 대시보드용 Single Sign-On 활성화

Ceph 대시보드는 SAML(Security Assertion Markup Language) 프로토콜을 사용하여 사용자의 외부 인증을 지원합니다. Ceph 대시 보드에서 SSO(Single Sign-On)를 사용하기 전에 대시보드 사용자 계정을 만들고 원하는 역할을 할당합니다. Ceph 대시보드는 사용자 권한 부여를 수행하고 인증 프로세스는 기존 IdMP(ID 공급자)에서 수행합니다. Red Hat은 Keycloak을 사용하여 대시보드 SSO 기능을 테스트합니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- Ceph 대시보드 소프트웨어 설치.

- 대시보드를 시작합니다.

- Ceph Manager 노드에 대한 루트 수준 액세스입니다.

Ceph Manager 노드에 다음 라이브러리 패키지를 설치합니다.

-

python3-saml -

python3-defusedxml -

python3-isodate -

python3-xmlsec

-

절차

Ceph 대시보드에서 SSO를 구성하려면 다음 명령을 실행합니다.

베어 메탈 배포:

구문

ceph dashboard sso setup saml2 CEPH_DASHBOARD_BASE_URL IDP_METADATA IDP_USERNAME_ATTRIBUTE IDP_ENTITY_ID SP_X_509_CERT SP_PRIVATE_KEY

예제

[root@mon ~]# ceph dashboard sso setup saml2 http://dashboard_hostname.ceph.redhat.com:8443 idp-metadata.xml username http://10.70.59.125:8080/auth/realms/realm_name /home/certificate.txt /home/private-key.txt

컨테이너 배포:

구문

podman exec CEPH_MGR_NODE ceph dashboard sso setup saml2 CEPH_DASHBOARD_BASE_URL IDP_METADATA IDP_USERNAME_ATTRIBUTE IDP_ENTITY_ID SP_X_509_CERT SP_PRIVATE_KEY

예제

[root@mon ~]# podman exec ceph-mgr-hostname ceph dashboard sso setup saml2 http://dashboard_hostname.ceph.redhat.com:8443 idp-metadata.xml username http://10.70.59.125:8080/auth/realms/realm_name /home/certificate.txt /home/private-key.txt

replace

-

Ceph

mgr노드가 있는CEPH _MGR_NODE 예:ceph-mgr-hostname - Ceph 대시보드에 액세스할 수 있는 기본 URL이 있는CEPH_DASHBOARD_BASE_ URL.

- IdP 메타데이터 XML의 원격 경로 또는 로컬 경로 또는 콘텐츠에 대한 URL이 있는 IDP_METADATA 입니다. 지원되는 URL 유형은 http, https 및 file입니다.

- 선택 사항: 인증 응답에서 사용자 이름을 가져오는 데 사용되는 속성이 있는IDP_USERNAME_ATTRIBUTE 입니다. 기본값은 uid 입니다.

- 선택 사항: IdP 메타데이터에 둘 이상의 엔터티 ID가 있는 경우 IdP 엔터티 ID가 있는IDP_ENTITY_ID 입니다.

- 선택 사항:SP_X_509_CERT 및 Ceph Dashboard에서 서명 및 암호화에 사용되는 인증서의 파일 경로입니다.

- 선택 사항: Ceph 대시보드에서 서명 및 암호화를 위해 사용하는 개인 키의 파일 경로가 있는SP_PRIVATE_KEY.

현재 SAML 2.0 구성을 확인합니다.

베어 메탈 배포:

구문

ceph dashboard sso show saml2

컨테이너 배포:

구문

podman exec CEPH_MGR_NODE ceph dashboard sso show saml2

SSO를 활성화하려면 다음 명령을 실행합니다.

베어 메탈 배포:

구문

ceph dashboard sso enable saml2 SSO is "enabled" with "SAML2" protocol.

컨테이너 배포:

구문

podman exec CEPH_MGR_NODE ceph dashboard sso enable saml2 SSO is "enabled" with "SAML2" protocol.

대시보드 URL을 엽니다. 예를 들어 다음과 같습니다.

http://dashboard_hostname.ceph.redhat.com:8443

- SSO 페이지에서 로그인 자격 증명을 입력합니다. SSO는 대시보드 웹 인터페이스로 리디렉션됩니다.

2.11. Ceph 대시보드의 Single Sign-On 비활성화

Ceph 대시보드의 SSO(Single Sign on)를 비활성화할 수 있습니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- Ceph 대시보드 소프트웨어 설치.

- 대시보드를 시작합니다.

- Ceph Manager 노드에 대한 루트 수준 액세스입니다.

- Ceph 대시보드에 대한 SSO(Single Sign-On 활성화)

Ceph Manager 노드에 다음 라이브러리 패키지를 설치합니다.

-

python3-saml -

python3-defusedxml -

python3-isodate -

python3-xmlsec

-

절차

SSO 상태를 보려면 다음 명령을 실행합니다.

베어 메탈 배포:

구문

ceph dashboard sso status SSO is "enabled" with "SAML2" protocol.

컨테이너 배포:

구문

podman exec CEPH_MGR_NODE ceph dashboard sso status SSO is "enabled" with "SAML2" protocol.replace

-

Ceph

mgr노드가 있는CEPH _MGR_NODE 예:ceph-mgr-hostname

-

Ceph

SSO를 비활성화하려면 다음 명령을 실행합니다.

베어 메탈 배포:

구문

ceph dashboard sso disable SSO is "disabled".

컨테이너 배포:

구문

podman exec CEPH_MGR_NODE ceph dashboard sso disable SSO is "disabled".replace

-

Ceph

mgr노드가 있는CEPH _MGR_NODE 예:ceph-mgr-hostname

-

Ceph

추가 리소스

- Single Sign-On을 활성화하려면 Red Hat Ceph StorageDashboard Guide 의 Enabling Single Sign-on for the Ceph Dashboard 를 참조하십시오.

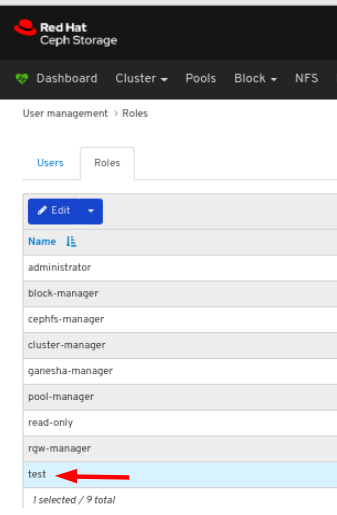

3장. 대시보드에서 역할 관리

스토리지 관리자는 대시보드에서 역할을 생성, 보기, 편집 및 삭제할 수 있습니다. 역할에 권한을 부여하고 사용자에게 특정 역할을 할당할 수 있습니다.

3.1. 대시보드에서 역할 생성

대시보드를 사용하면 사용자에게 할당할 수 있는 역할을 대시보드에 만들 수 있습니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 대시보드가 설치되어 있습니다.

- 대시보드에 대한 관리자 액세스 수준입니다.

절차

- 대시보드에 로그인합니다.

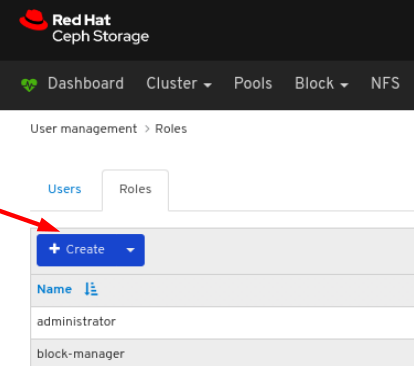

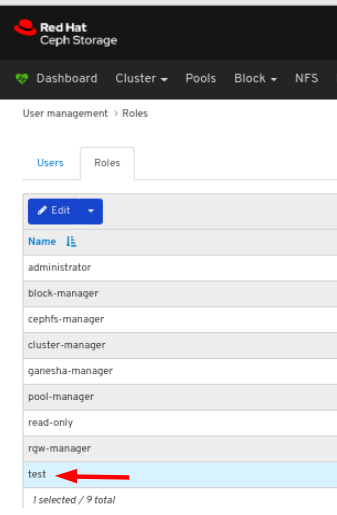

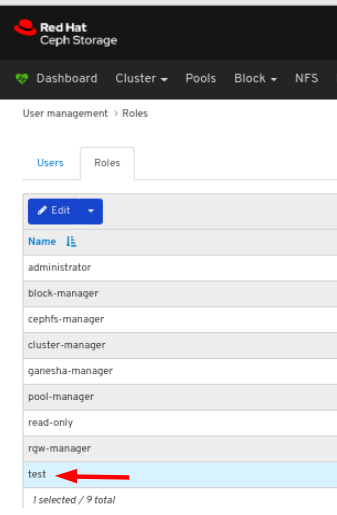

대시보드 오른쪽 상단에서 톱니바퀴 아이콘을 클릭하고 사용자 관리를 선택합니다.

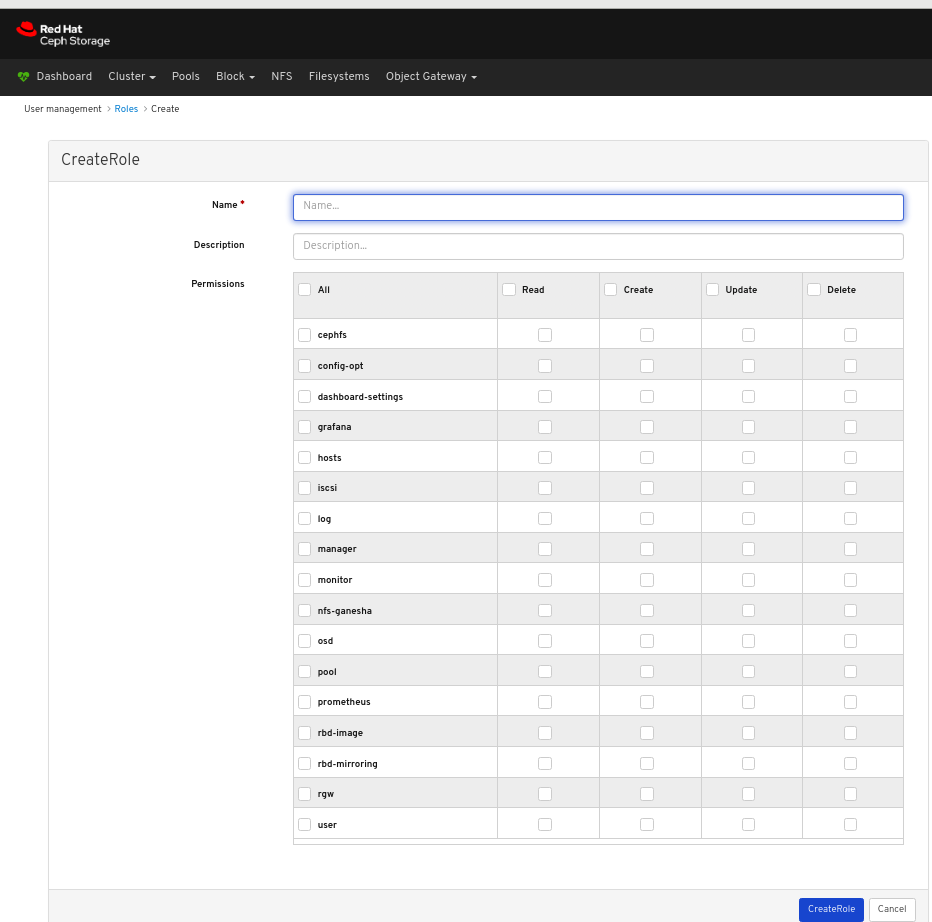

Roles (역할) 탭에서 생성 버튼을 클릭합니다.

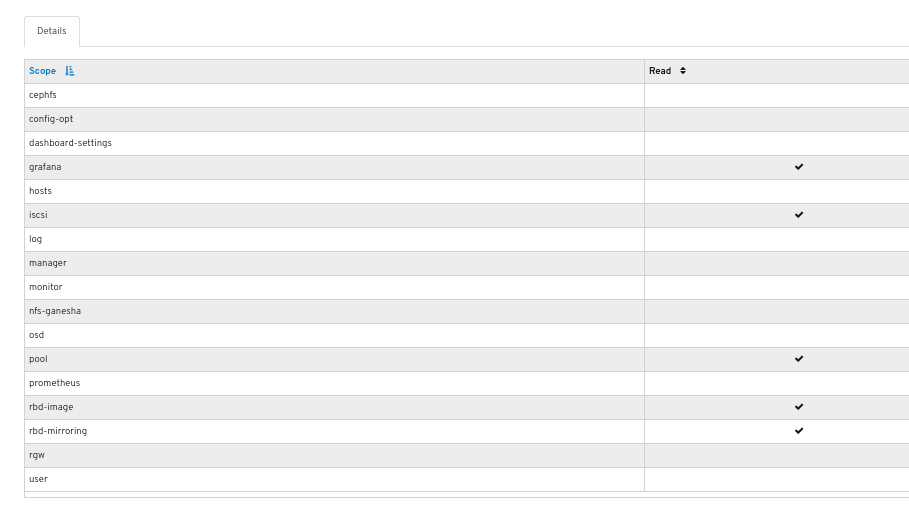

CreateRole 창에서 Name 을 설정하고 이 역할에 대한 Permissions 를 선택한 다음 CreateRole 버튼을 클릭합니다.

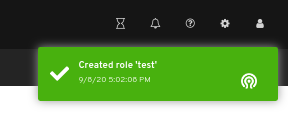

페이지 오른쪽 상단 모서리에 대한 알림은 역할이 성공적으로 생성되었음을 나타냅니다.

3.2. 대시보드에서 역할 보기

대시보드를 사용하면 대시보드의 역할 세부 정보를 볼 수 있습니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 대시보드가 설치되어 있습니다.

- 대시보드에 대한 관리자 액세스 수준입니다.

- 역할은 대시보드에서 생성됩니다.

절차

- 대시보드에 로그인합니다.

대시보드 오른쪽 상단에서 톱니바퀴 아이콘을 클릭하고 사용자 관리를 선택합니다.

역할의 세부 정보를 보려면 행을 클릭합니다.

역할에 대해 제공된 권한의 세부 정보를 확인할 수 있습니다.

추가 리소스

- 자세한 내용은 Red Hat Ceph Storage Dashboard Guide 의 Creating roles on the dashboard 섹션을 참조하십시오.

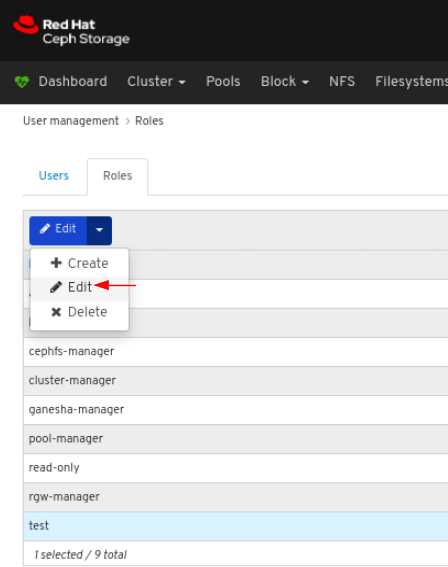

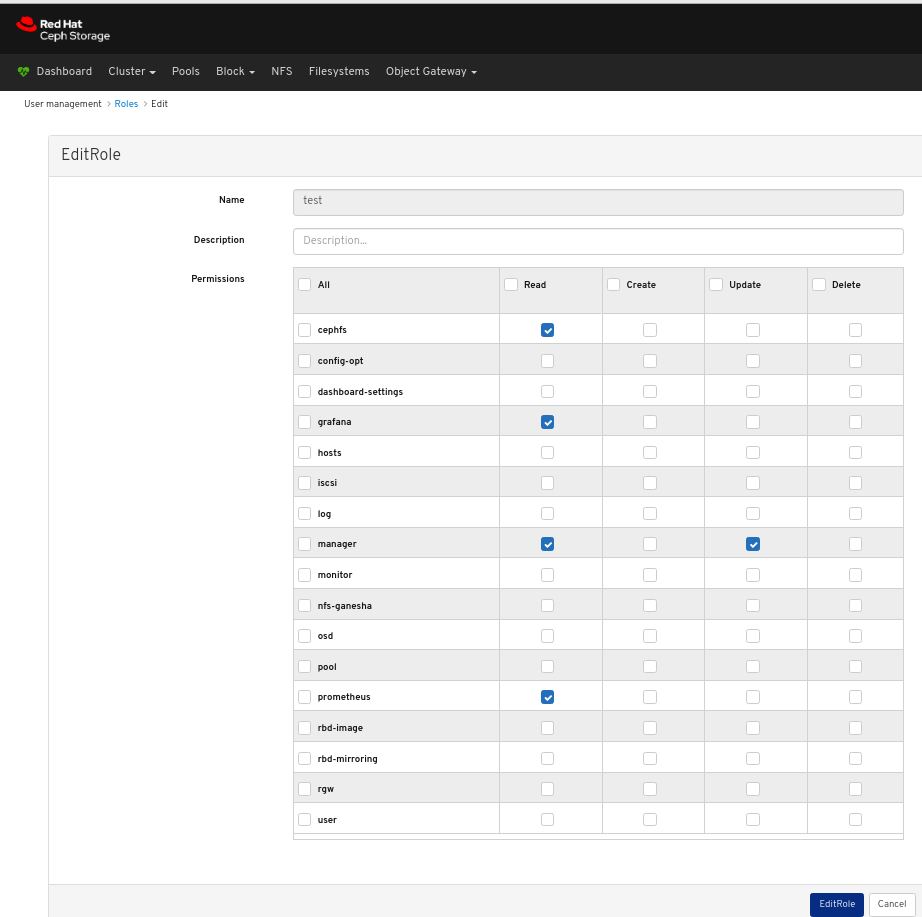

3.3. 대시보드에서 역할 편집

대시보드를 사용하면 대시보드에서 역할을 편집할 수 있습니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 대시보드가 설치되어 있습니다.

- 대시보드에 대한 관리자 액세스 수준입니다.

- 대시보드에 역할이 생성됩니다.

절차

- 대시보드에 로그인합니다.

대시보드 오른쪽 상단에서 톱니바퀴 아이콘을 클릭하고 사용자 관리를 선택합니다.

역할을 편집하려면 행을 클릭합니다.

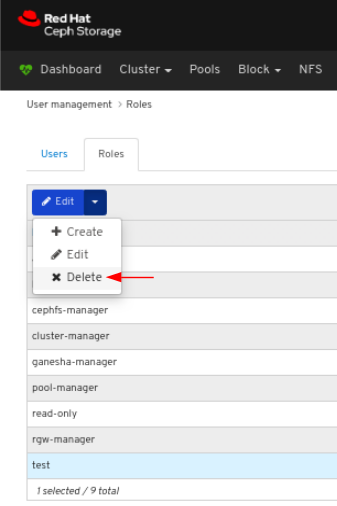

Roles (역할) 탭의 Edit(편집) 드롭다운 메뉴에서 Edit (편집)를 선택합니다.

EditRole 창에서 를 포함한 매개 변수를 편집한 다음 EditRole 버튼을 클릭합니다.

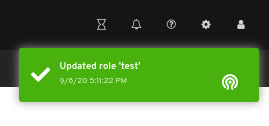

페이지 오른쪽 상단 모서리에 대한 알림은 역할이 성공적으로 업데이트되었음을 나타냅니다.

추가 리소스

- 자세한 내용은 Red Hat Ceph Storage Dashboard Guide 의 Creating roles on the dashboard 섹션을 참조하십시오.

3.4. 대시보드에서 역할 삭제

대시보드를 사용하면 대시보드에서 역할을 삭제할 수 있습니다.

생성한 역할만 삭제할 수 있습니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 대시보드가 설치되어 있습니다.

- 대시보드에 대한 관리자 액세스 수준입니다.

- 대시보드에 역할이 생성됩니다.

절차

- 대시보드에 로그인합니다.

대시보드 오른쪽 상단에서 톱니바퀴 아이콘을 클릭하고 사용자 관리를 선택합니다.

역할을 삭제하려면 행을 클릭합니다.

Roles (역할) 탭의 Edit 드롭다운 메뉴에서 Delete 를 선택합니다.

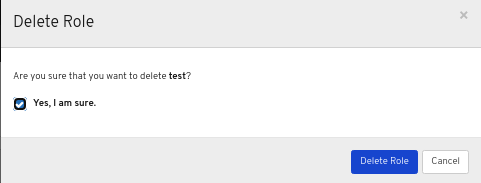

역할 삭제 대화 상자에서 예, 예, 확인 대화 상자를 클릭한 다음 역할 삭제를 클릭하여 설정을 저장합니다.In the Delete Role dialog box, click the Yes, I am sure box and then click Delete Role to save the settings:

추가 리소스

- 자세한 내용은 Red Hat Ceph Storage Dashboard Guide 의 Creating roles on the dashboard 섹션을 참조하십시오.

4장. 대시보드에서 사용자 관리

스토리지 관리자는 대시보드에서 사용자를 생성, 편집 및 삭제할 수 있습니다.

4.1. 대시보드에서 사용자 만들기

대시보드를 사용하면 대시보드에서 사용자를 만들 수 있습니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 대시보드가 설치되어 있습니다.

- 대시보드에 대한 관리자 액세스 수준입니다.

Red Hat Ceph Storage 대시보드는 사용자 암호를 변경할 때 이메일 확인을 지원하지 않습니다. 대시보드가 SSO(Single Sign-On)를 지원하며 이 기능은 SSO 공급자에 위임될 수 있으므로 이 동작은 의도적입니다.

절차

- 대시보드에 로그인합니다.

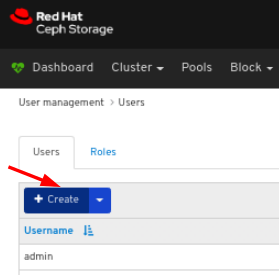

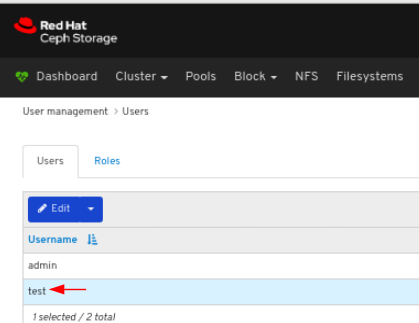

대시보드 오른쪽 상단에서 톱니바퀴 아이콘을 클릭하고 사용자 관리를 선택합니다.

사용자 탭에서 생성 버튼을 클릭합니다.

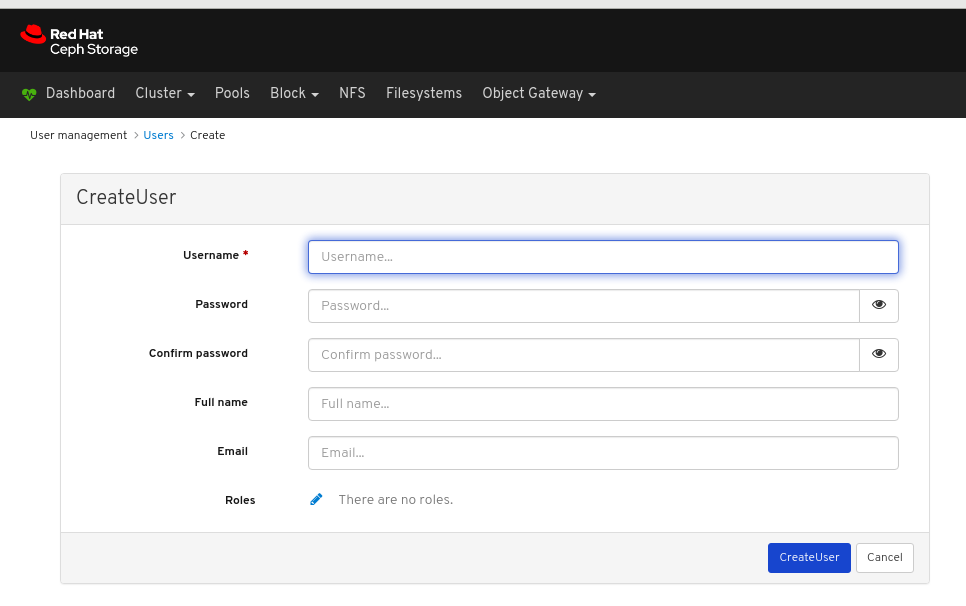

CreateUser 창에서 역할을 포함한 Username 및 기타 매개 변수를 설정한 다음 _CreateUser_button을 클릭합니다.

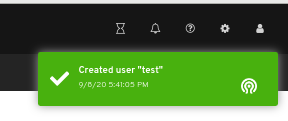

페이지 오른쪽 상단 모서리에 대한 알림은 사용자가 성공적으로 생성되었음을 나타냅니다.

추가 리소스

- 자세한 내용은 Red Hat Ceph Storage Dashboard Guide 의 Creating roles on dashboard 섹션을 참조하십시오.

4.2. 대시보드에서 사용자 편집

대시보드를 사용하면 대시보드에서 사용자를 편집할 수 있습니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 대시보드가 설치되어 있습니다.

- 대시보드에 대한 관리자 액세스 수준입니다.

- 대시보드에서 생성된 사용자입니다.

절차

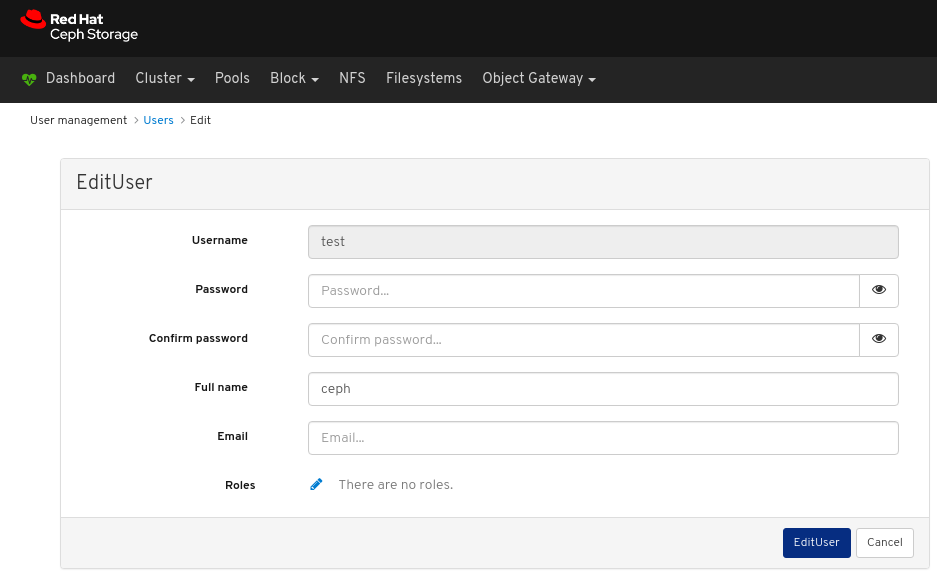

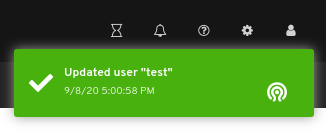

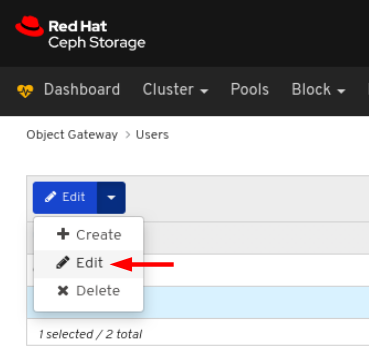

- 대시보드에 로그인합니다.

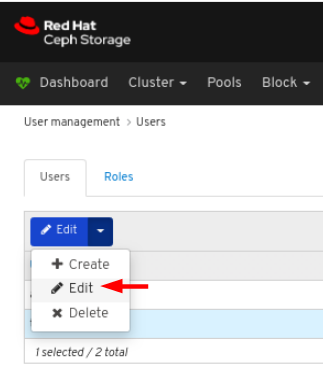

대시보드 오른쪽 상단에서 톱니바퀴 아이콘을 클릭하고 사용자 관리를 선택합니다.

사용자를 편집하려면 행을 클릭합니다.

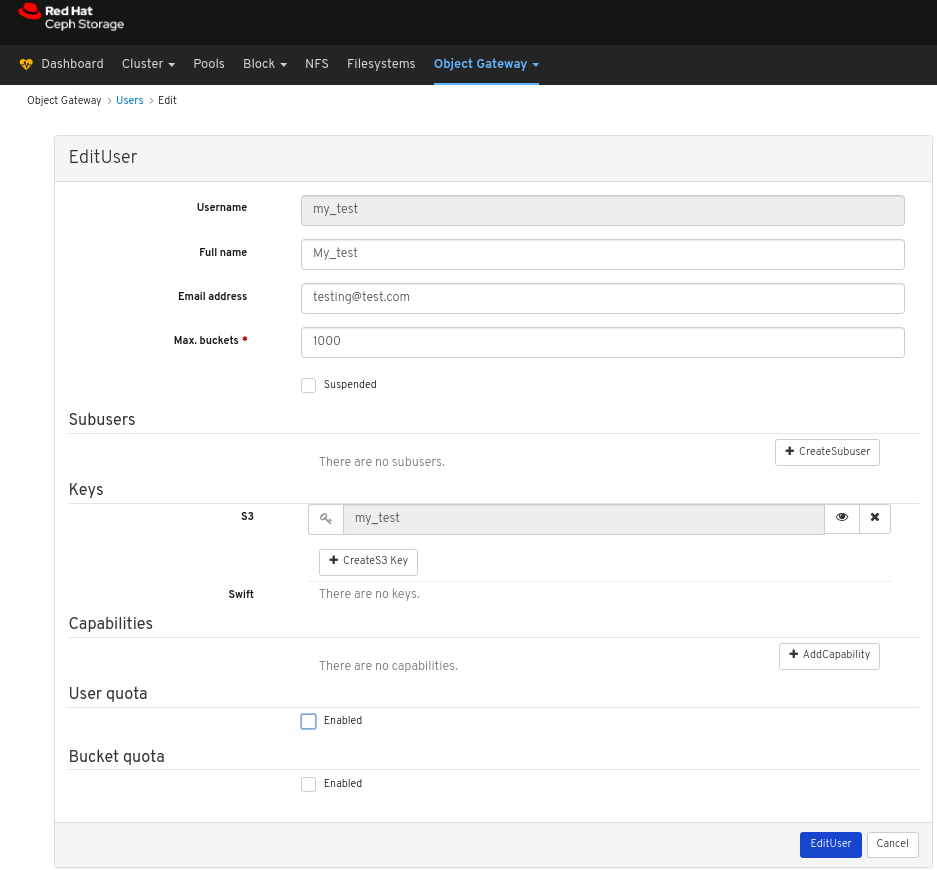

Users (사용자) 탭의 Edit (편집) 드롭다운 메뉴에서 Edit (편집)를 선택합니다.

EditUser 창에서 를 포함한 매개 변수를 편집한 다음 EditUser 버튼을 클릭합니다.

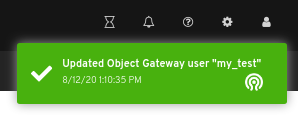

페이지 오른쪽 상단 모서리에 대한 알림은 사용자가 성공적으로 업데이트되었음을 나타냅니다.

추가 리소스

- 자세한 내용은 Red Hat Ceph Storage 대시보드 가이드의 대시보드에서 사용자 생성 섹션을 참조하십시오.

4.3. 대시보드에서 사용자 삭제

대시보드를 사용하면 대시보드에서 사용자를 삭제할 수 있습니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 대시보드가 설치되어 있습니다.

- 대시보드에 대한 관리자 액세스 수준입니다.

- 대시보드에서 생성된 사용자입니다.

절차

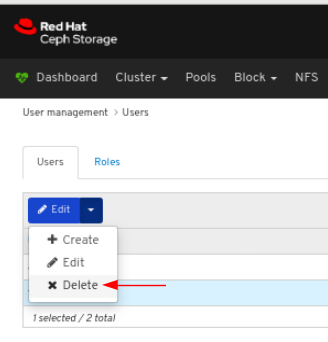

- 대시보드에 로그인합니다.

대시보드 오른쪽 상단에서 톱니바퀴 아이콘을 클릭하고 사용자 관리를 선택합니다.

사용자를 삭제하려면 행을 클릭합니다.

Users (사용자) 탭의 Edit 드롭다운 메뉴에서 Delete 를 선택합니다.

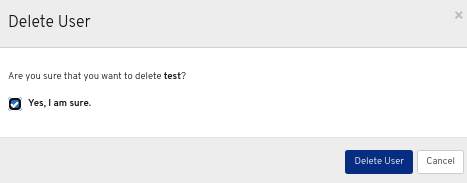

사용자 삭제 대화 상자 창에서 예, 예, 확인 대화 상자를 클릭한 다음 사용자 삭제를 클릭하여 설정을 저장합니다.In the Delete User dialog window, click the Yes, I am sure box and then click Delete user to save the settings:

추가 리소스

- 자세한 내용은 Red Hat Ceph Storage 대시보드 가이드의 대시보드에서 사용자 생성 섹션을 참조하십시오.

5장. 클러스터 모니터링

대시보드의 모니터링 기능은 스토리지 클러스터의 다양한 측면을 나타내기 위해 정기적으로 업데이트하는 다양한 웹 페이지를 제공합니다. 시작 페이지를 사용하여 클러스터의 전체 상태를 모니터링하거나 블록 장치 이미지와 같은 클러스터의 특정 기능을 모니터링할 수 있습니다.

추가 리소스

- 자세한 내용은 대시보드 가이드 의 시작 페이지 액세스를 참조하십시오.

- 자세한 내용은 대시보드 가이드의 시작 페이지 이해를 참조하십시오.

- 자세한 내용은 대시보드 가이드의 특정 기능 모니터링 을 참조하십시오.

5.1. 시작 페이지에 액세스

대시보드에 로그인하면 시작 페이지가 로드됩니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 대시보드가 설치되어 있습니다.

절차

대시보드에 로그인합니다.

대시보드에 로그인하면 시작 페이지가 로드됩니다.

다른 대시보드 페이지를 확인한 후 시작 페이지로 돌아가려면 페이지의 왼쪽 상단 모서리에 대한 대시보드 를 클릭합니다.

추가 리소스

- 자세한 내용은 대시보드 가이드의 시작 페이지 이해를 참조하십시오.

- 자세한 내용은 대시보드 가이드의 특정 기능 모니터링 을 참조하십시오.

5.2. 시작 페이지 이해

시작 페이지에는 개별 패널을 사용하는 전체 Ceph 클러스터에 대한 개요가 표시됩니다. 각 패널에는 클러스터 상태에 대한 특정 정보가 표시됩니다.

카테고리

시작 페이지는 다음 세 가지 범주로 구성된 패널을 구성합니다.

- 상태

- 용량

- 성능

상태 패널

상태 패널에는 클러스터 및 호스트 및 데몬 상태의 상태가 표시됩니다.

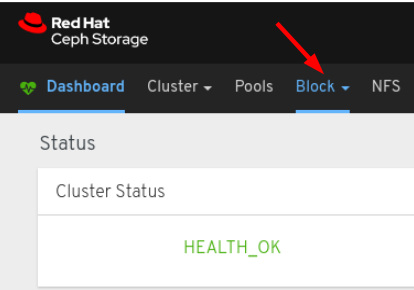

클러스터 상태: Ceph 클러스터의 현재 상태를 표시합니다.

hosts: Ceph 스토리지 클러스터에 있는 총 호스트 수를 표시합니다.

Monitor: Ceph 모니터 수 및 쿼럼 상태를 표시합니다.

OSD: Ceph Storage 클러스터의 총 OSD 수와 up, 의 수 를 표시합니다.

managers: Manager 데몬의 수 및 상태를 표시합니다.

Object Gateways: Ceph 스토리지 클러스터에 있는 오브젝트 게이트웨이 수를 표시합니다.

metadata Servers: Ceph Filesystems의 메타데이터 서버의 수와 상태를 표시합니다.

iSCSI 게이트웨이: Ceph 스토리지 클러스터에 iSCSI 게이트웨이 수를 표시합니다.

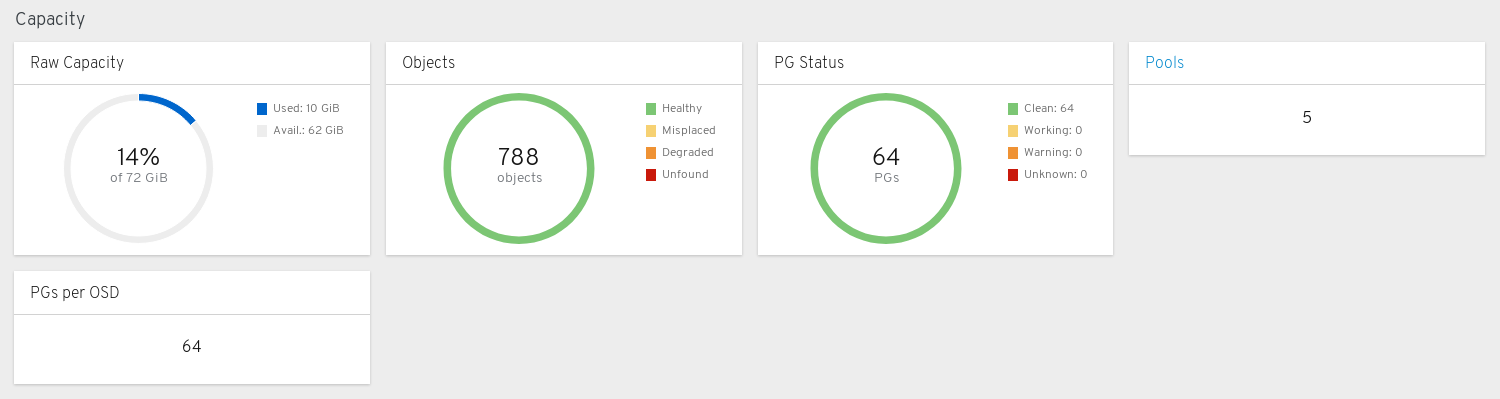

용량 패널

용량 패널은 스토리지 사용 지표를 표시합니다.

Raw Capacity: 클러스터의 원시 스토리지 용량의 사용률과 가용성을 표시합니다.

Object: 풀의 총 오브젝트 수와 그래프를 Healthy,Misplaced,Degraded 또는 Unfound 의 상태로 나눕니다.

PG 상태: 총 배치 그룹 수와 PG를 클리어 작업,경고 또는 알 수 없는 상태로 분할하는 그래프를 표시합니다. PG 상태 워킹 및 경고의 디스플레이를 단순화하기 위해 실제로 여러 상태를 포함합니다.

작업 상태에는 다음 상태의 PG가 포함됩니다.

- 활성화

- backfill_wait

- 백필링

- 생성

- 딥

- Degraded

- forced_backfill

- forced_recovery

- 피어링

- peered

- 복구

- recovery_wait

- 복구

- 스크럽

- snaptrim

- snaptrim_wait

경고 상태에는 다음 상태의 PG가 포함됩니다.

- backfill_toofull

- backfill_unfound

- down

- 불완전한 경우

- 일관되지 않음

- recovery_toofull

- recovery_unfound

- 재대 매핑

- snaptrim_error

- stale

- undersized

pool: Ceph 클러스터에 있는 스토리지 풀 수를 표시합니다.

OSD당 PGS: OSD당 배치 그룹 수를 표시합니다.

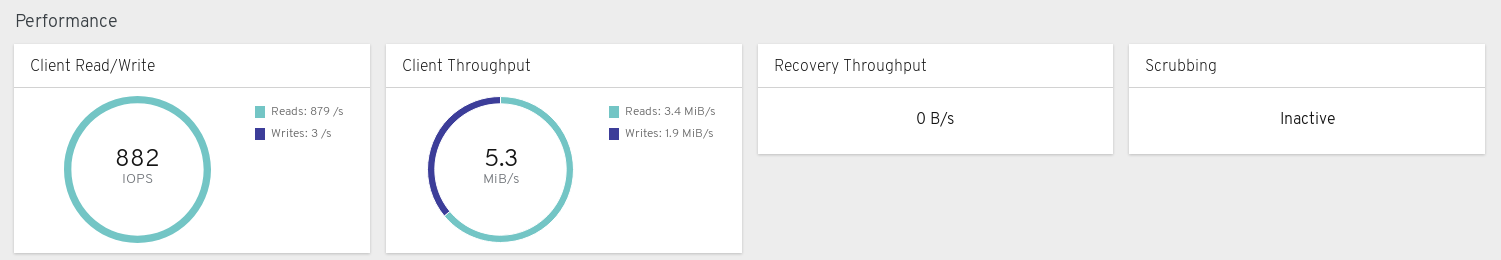

성능 패널

성능 패널은 데이터 전송 속도와 관련된 정보를 표시합니다.

클라이언트 읽기/쓰기: 초당 총 입력/출력 작업, 초당 읽기 및 초당 쓰기를 표시합니다.

클라이언트 처리량: 총 클라이언트 처리량, 읽기 처리량, 쓰기 처리량을 표시합니다.

복구 지원: 고객 복구율을 표시합니다.

scrubbing: Ceph가 데이터를 스크럽하여 무결성을 확인할지 여부를 표시합니다.

추가 리소스

- 자세한 내용은 대시보드 가이드 의 시작 페이지 액세스를 참조하십시오.

- 자세한 내용은 대시보드 가이드의 특정 기능 모니터링 을 참조하십시오.

6장. 특정 기능 모니터링

스토리지 관리자는 Red Hat Ceph Storage 대시보드를 사용하여 호스트, 서비스, 데이터 액세스 방법 등에 따라 클러스터의 특정 측면을 모니터링할 수 있습니다.

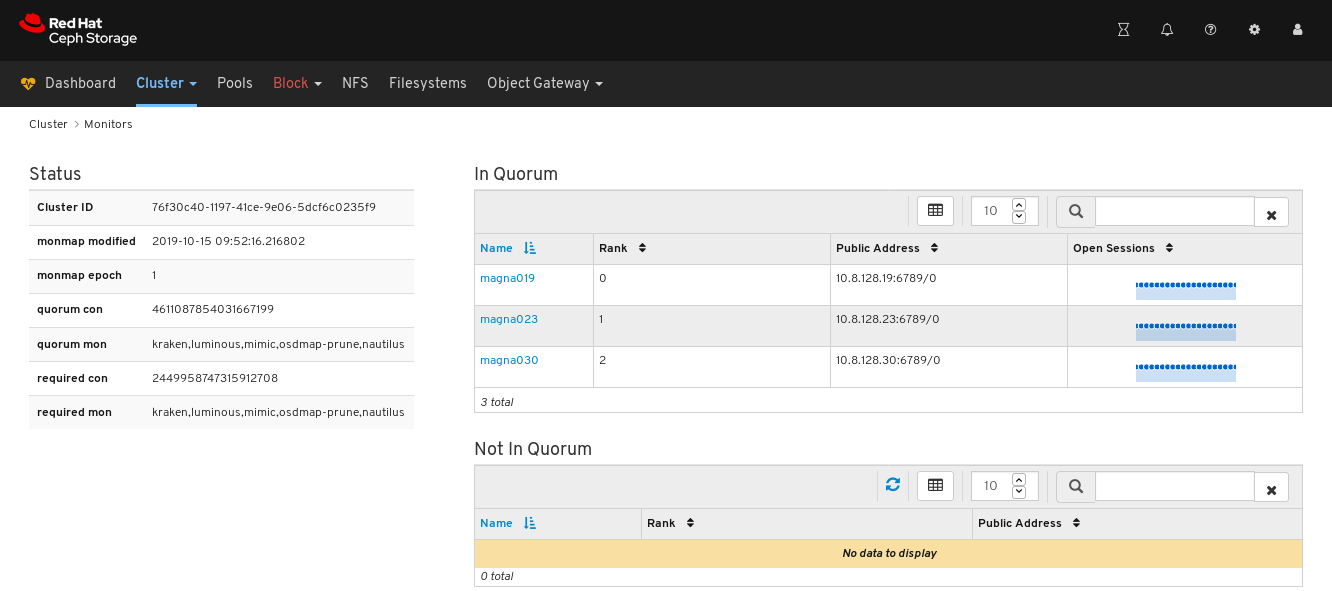

6.1. 모니터링 모니터

Red Hat Ceph Storage 대시보드를 사용하면 모니터 노드에 대한 다양한 세부 정보를 볼 수 있습니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 대시보드가 설치되어 있습니다.

절차

- 대시보드에 로그인합니다.

- 탐색 모음에서 클러스터를 클릭한 다음 모니터를 클릭합니다.On the navigation bar, click Cluster and then click Monitor.

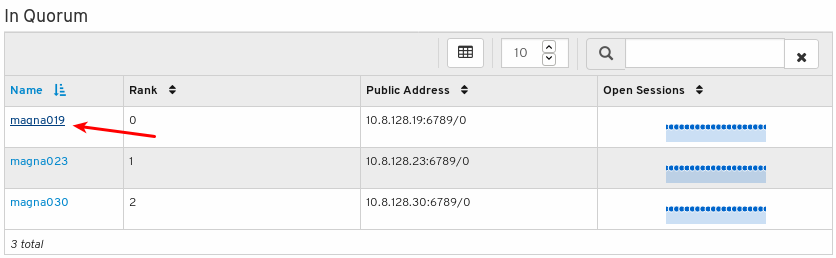

모니터 개요 페이지에는 전체 모니터 상태에 대한 정보와 Quorum 및 쿼럼 모니터 노드의 테이블이 표시됩니다.

열린 세션의 수를 보려면 파란색 점으로 커서를 가리키십시오.

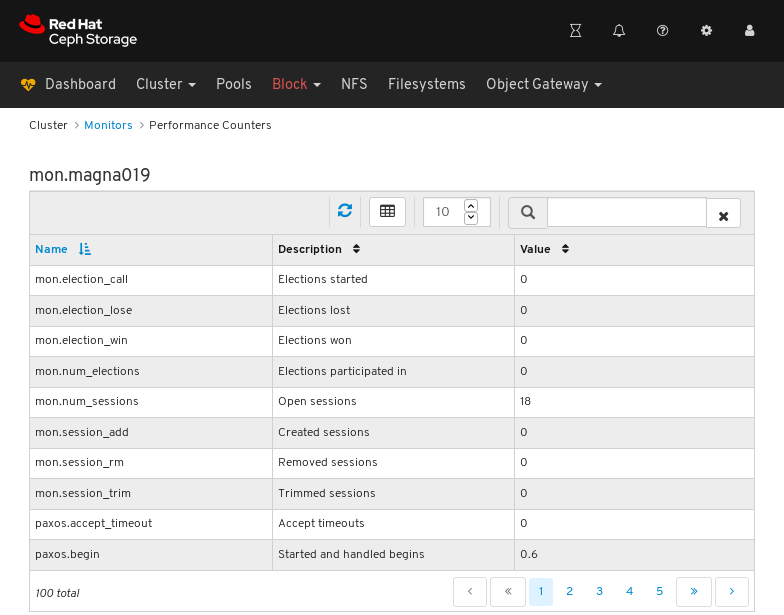

모니터에 대한 성능 카운터를 보려면 해당 호스트 이름을 클릭합니다.

성능 카운터 보기:

추가 리소스

- 모니터에 대한 자세한 내용은 운영 가이드의 Ceph 모니터를 참조하십시오.

- 성능 카운터에 대한 자세한 내용은 관리 가이드의 성능 카운터를 참조하십시오.For more information about performance counters, see Performance counters in the Administration Guide

6.2. 호스트 모니터링

Red Hat Ceph Storage 대시보드를 사용하면 호스트에 대한 다양한 세부 정보를 볼 수 있습니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 대시보드가 설치되어 있습니다.

절차

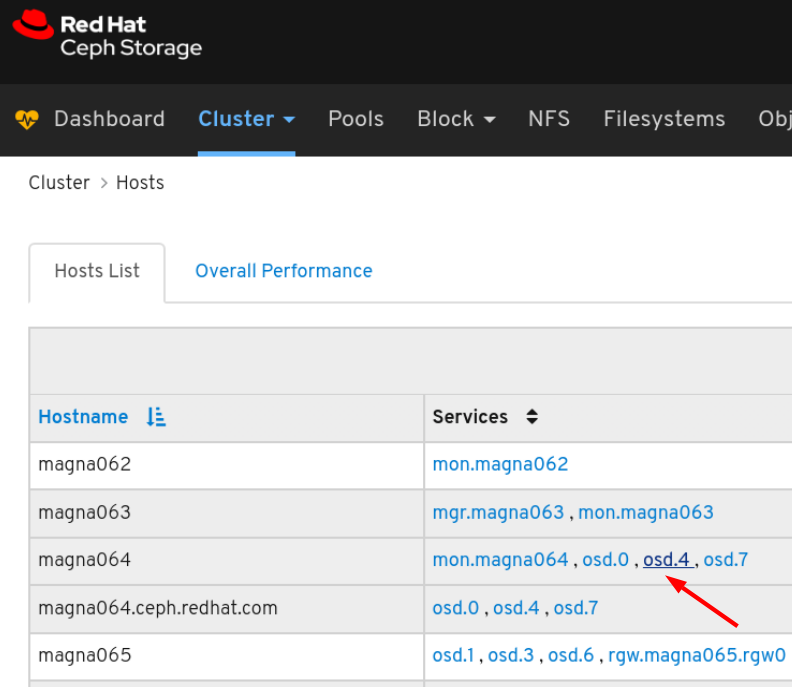

- 대시보드에 로그인합니다.

- 탐색 모음에서 클러스터를 클릭한 다음 Hosts ( 호스트)를 클릭합니다.

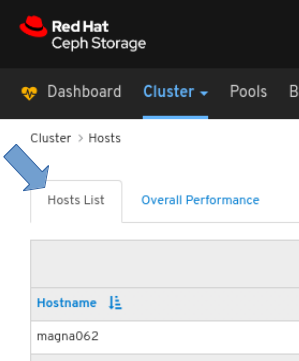

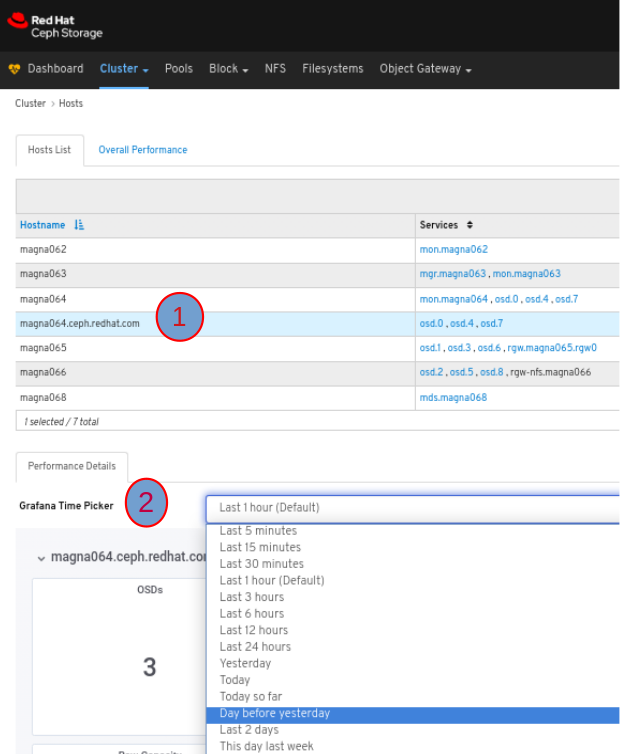

호스트 목록을 보려면 Hosts List 탭을 클릭합니다.

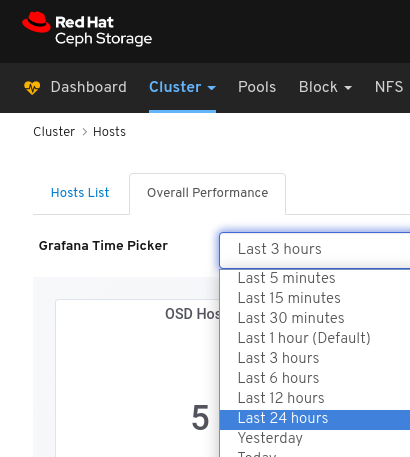

호스트의 성능 세부 정보를 보려면 Host 탭에서 해당 행을 클릭하고 Grafana Time choosinger 드롭다운 메뉴에서 시간 범위를 선택합니다.

호스트에서 특정 서비스의 성능 카운터를 보려면 서비스를 클릭합니다.

성능 카운터 보기:

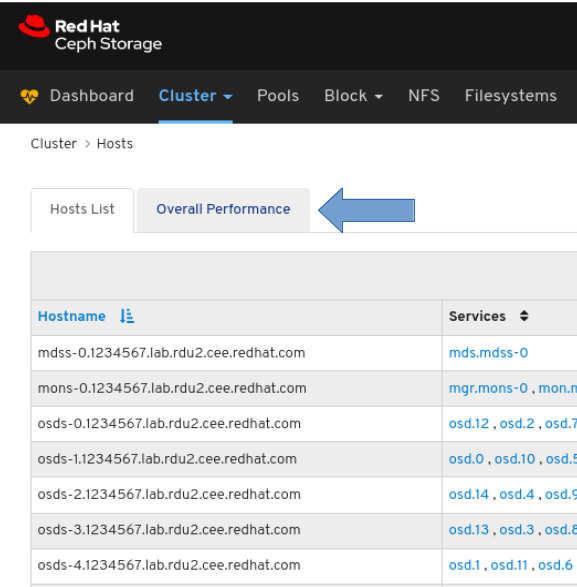

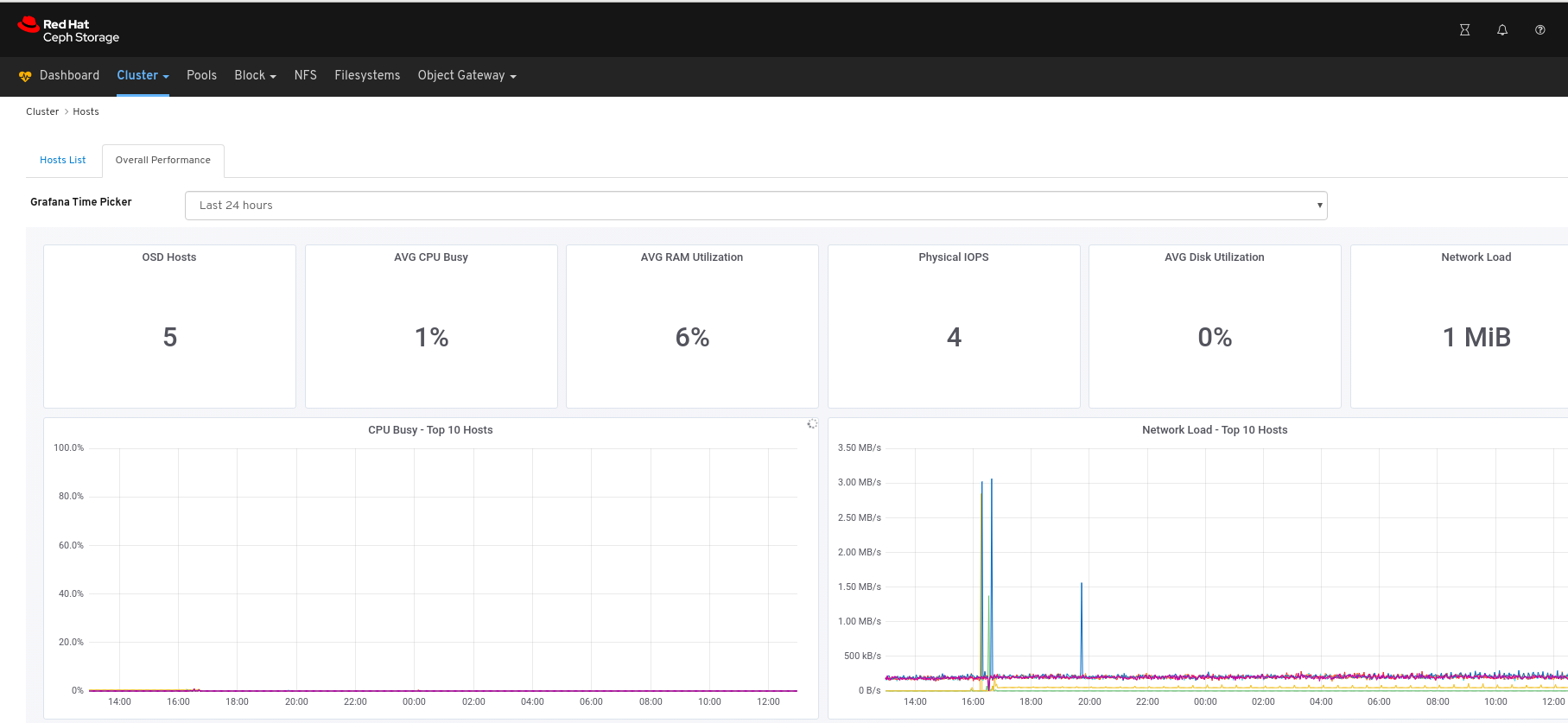

모든 호스트의 성능 데이터를 보려면 다음을 수행합니다.

페이지 왼쪽 상단에서 Overall Performance 탭을 클릭합니다.

Grafana Time choosinger 드롭다운에서 시간 범위를 선택합니다.

Overall Performance 페이지 보기:

추가 리소스

- 자세한 내용은 Red Hat Ceph Storage 관리 가이드 의 성능 카운터 를 참조하십시오.

6.3. OSD 모니터링

Red Hat Ceph Storage 대시보드를 사용하면 OSD에 대한 다양한 세부 정보를 볼 수 있습니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 대시보드가 설치되어 있습니다.

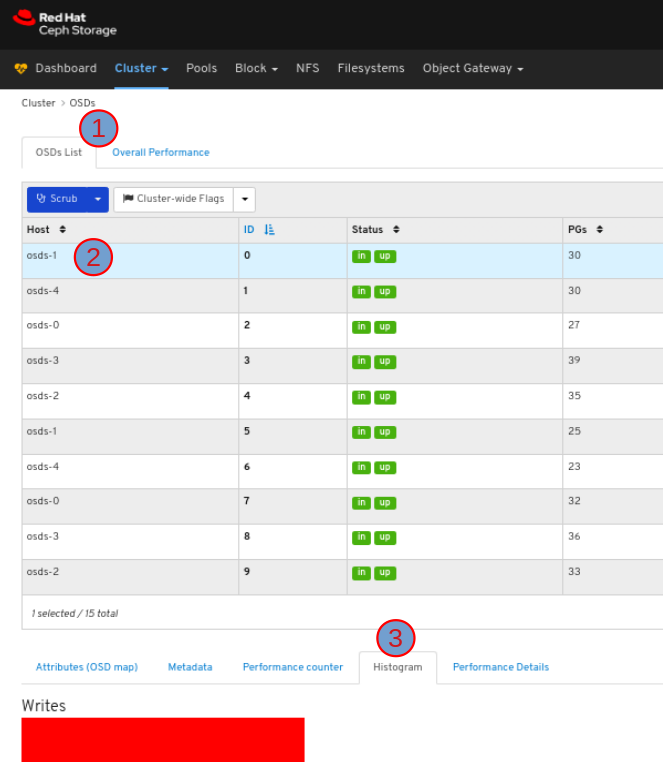

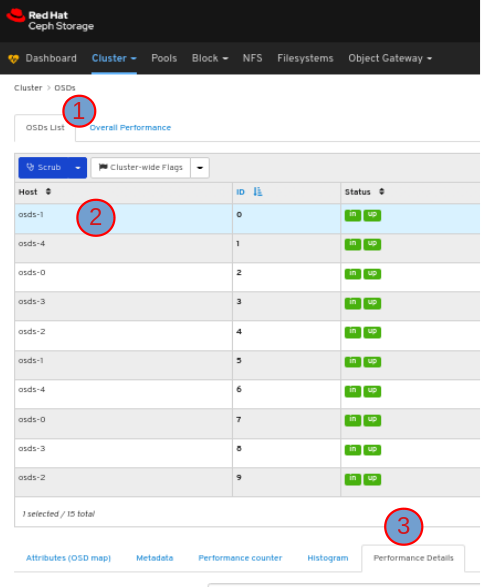

절차

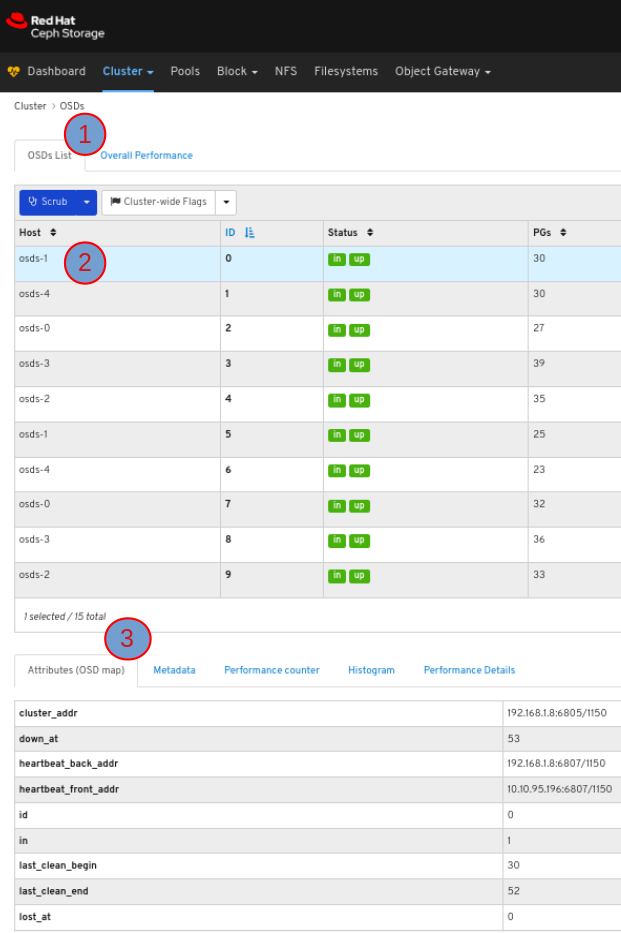

- 대시보드에 로그인합니다.

- 탐색 모음에서 클러스터를 클릭한 다음 OSD 를 클릭합니다.

OSD 목록을 보려면 OSD 목록 탭을 클릭합니다.

OSDS List 탭에서 OSD 특성을 보려면 해당 행을 클릭합니다.

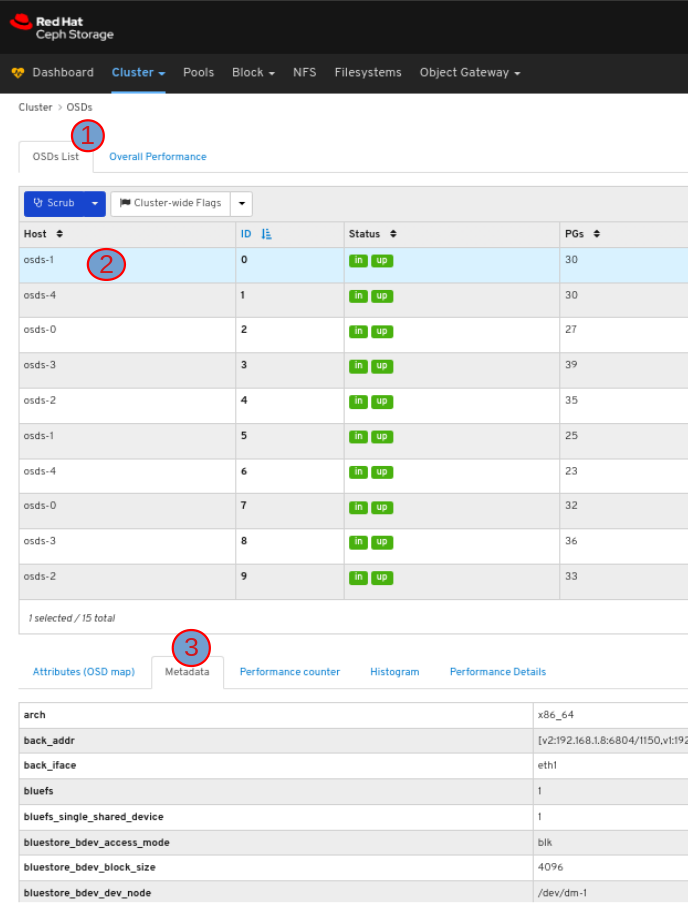

OSD 탭에서 OSD의 메타데이터를 보려면 해당 행을 클릭하고 Metadata 탭을 클릭합니다.

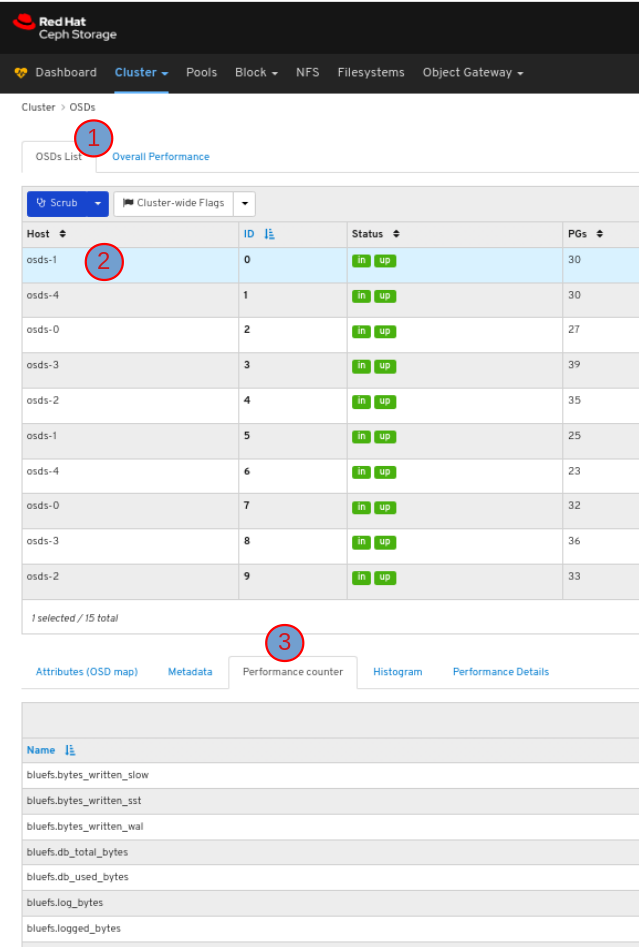

OSD 탭에서 OSD의 성능 카운터를 보려면 해당 행을 클릭하고 Performance counter 탭을 클릭합니다.

OSD 탭에서 OSD의 히스토그램을 보려면 해당 행을 클릭하고 Histogram 탭을 클릭합니다.

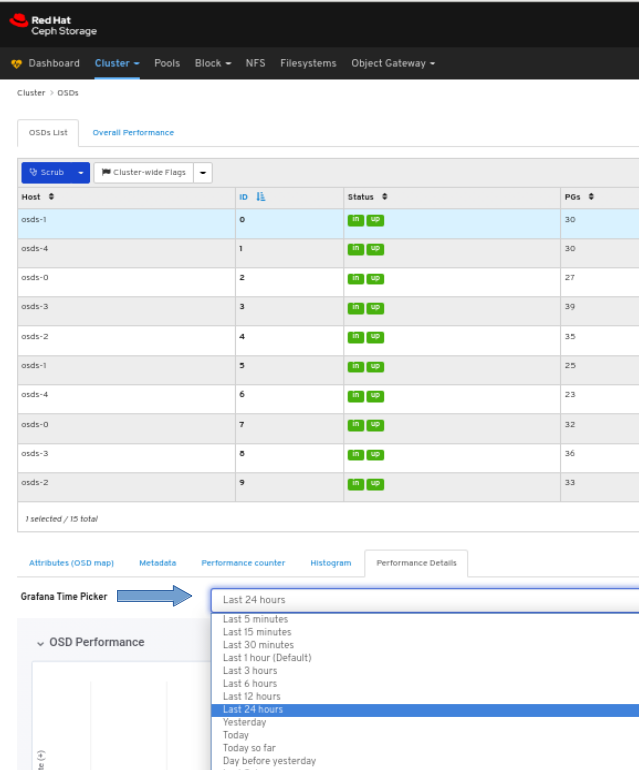

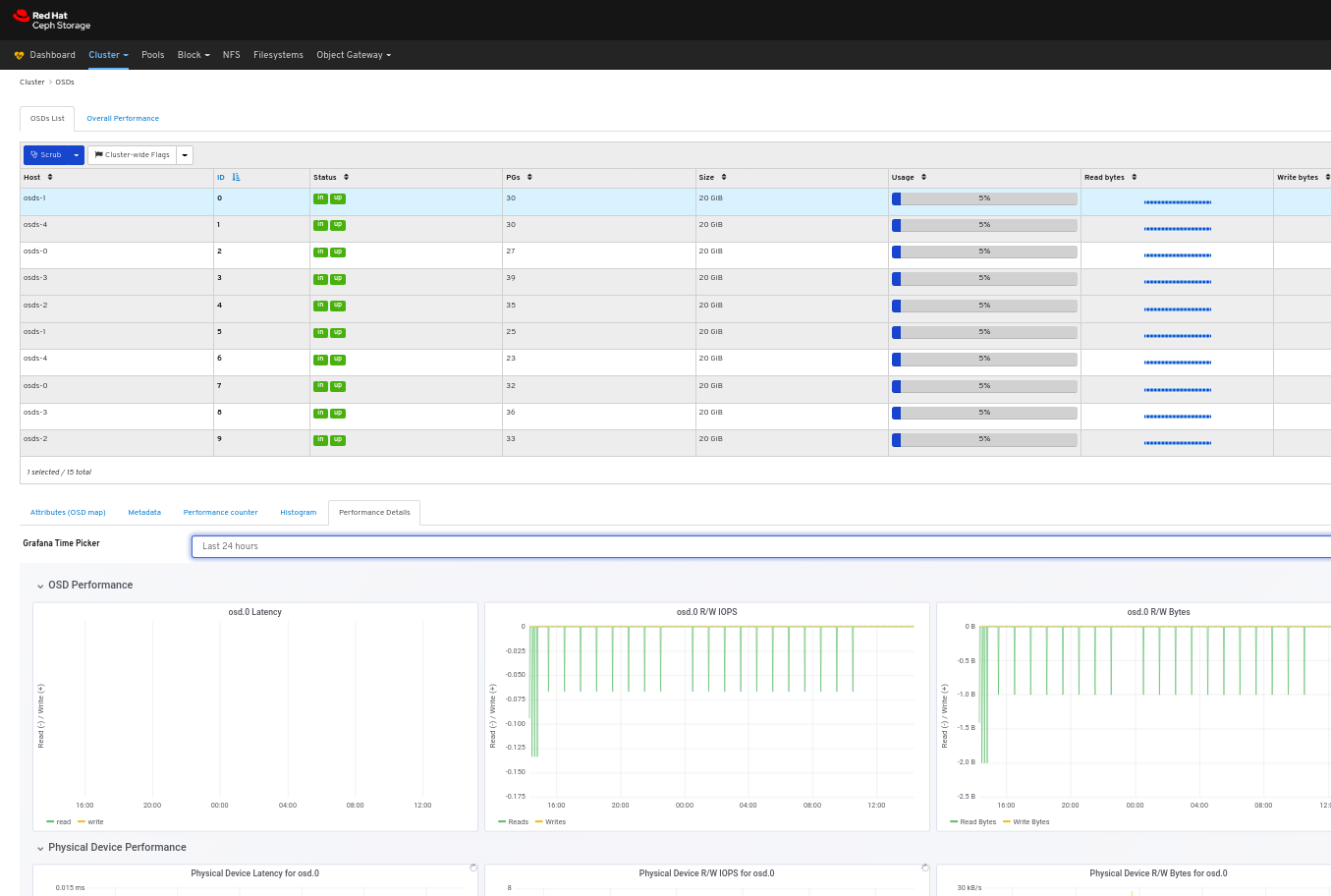

OSD의 성능 세부 정보를 보려면 다음을 수행합니다.

OSD 탭에서 해당 행을 클릭하고 성능 세부 정보 탭을 클릭합니다.

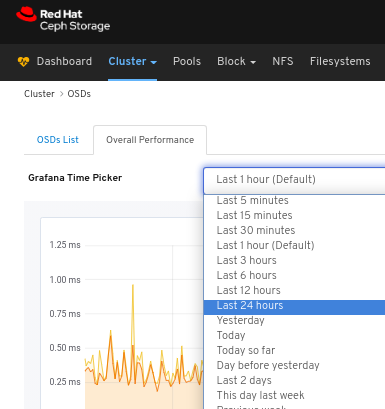

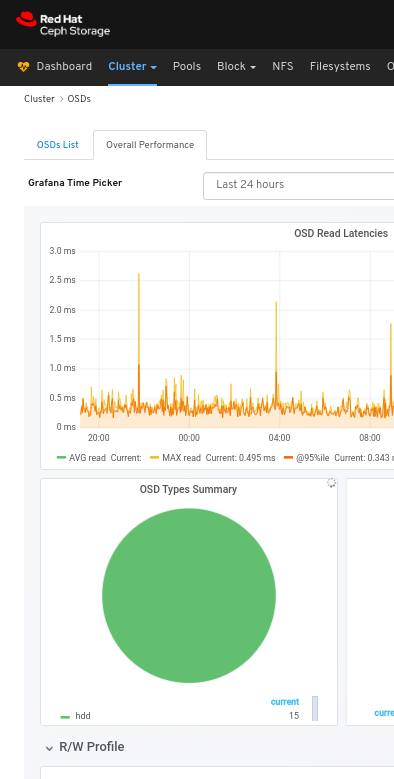

Grafana Time choosinger 드롭다운 메뉴에서 시간 범위를 선택합니다.

OSD의 성능 세부 정보를 확인합니다.

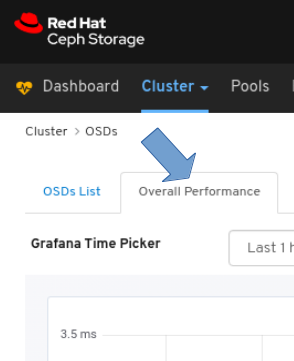

모든 OSD의 전반적인 성능을 보려면 다음을 수행합니다.

페이지 왼쪽 상단에서 Overall Performance 탭을 클릭합니다.

Grafana Time choosinger 드롭다운에서 시간 범위를 선택합니다.

Overall Performance 페이지 보기:

추가 리소스

- 자세한 내용은 Red Hat Ceph Storage 관리 가이드 의 성능 카운터 를 참조하십시오.

6.4. 풀 모니터링

Red Hat Ceph Storage 대시보드를 사용하면 클러스터의 풀에 대한 다양한 세부 정보를 볼 수 있습니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 대시보드가 설치되어 있습니다.

절차

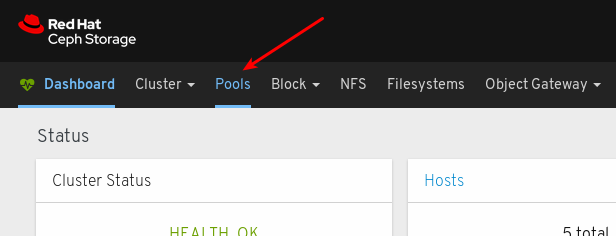

- 대시보드에 로그인합니다.

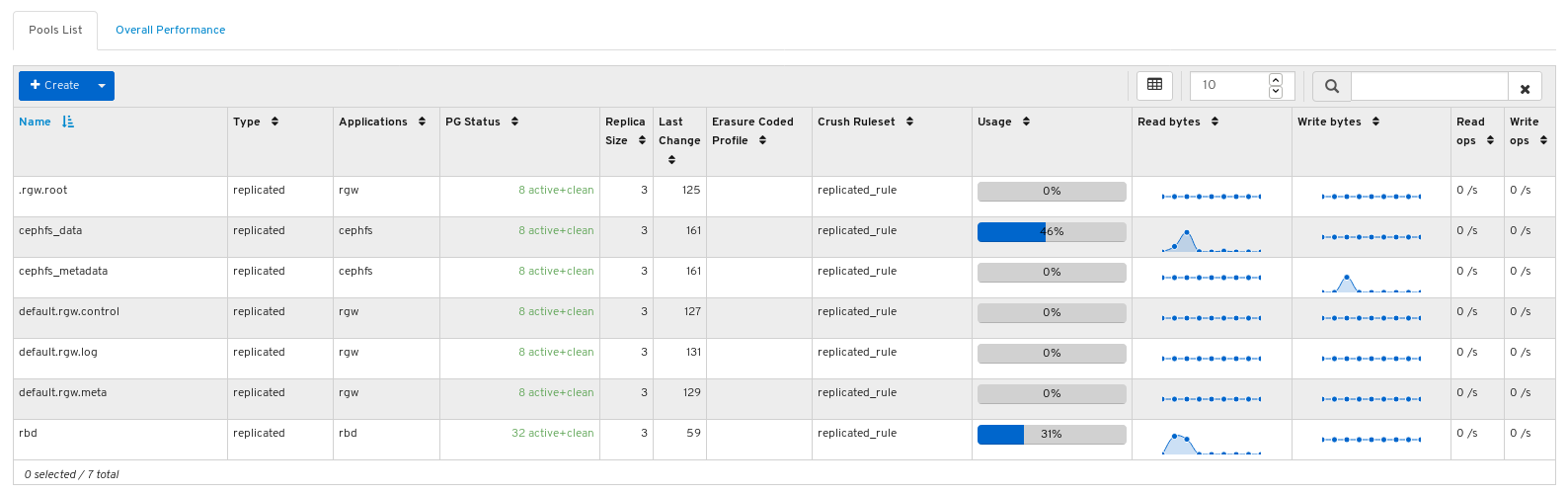

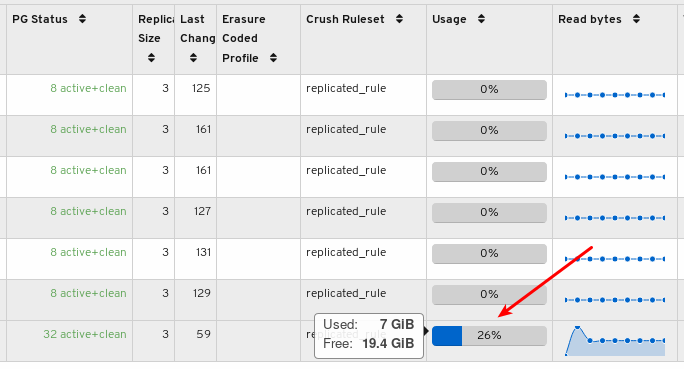

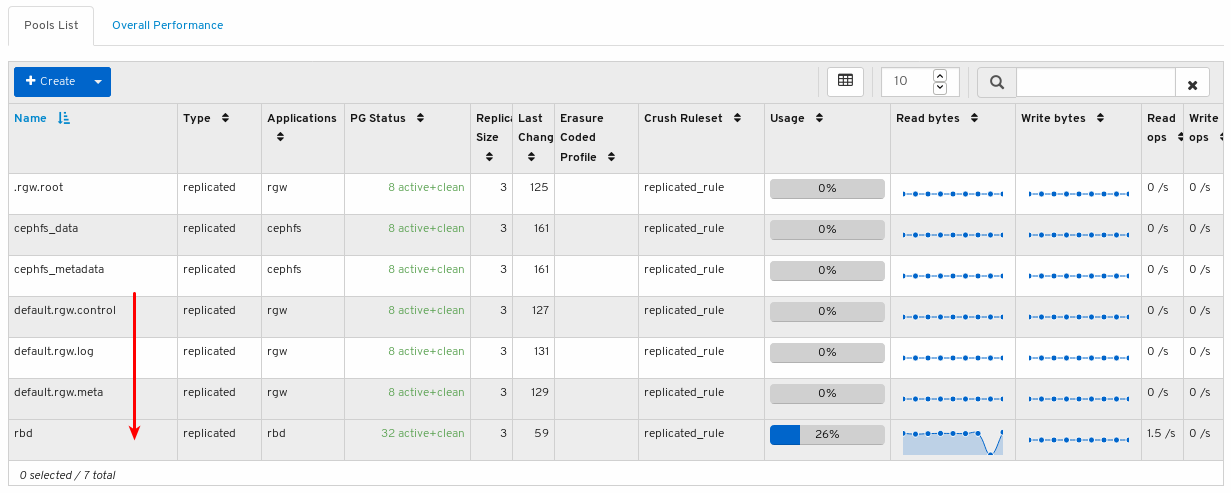

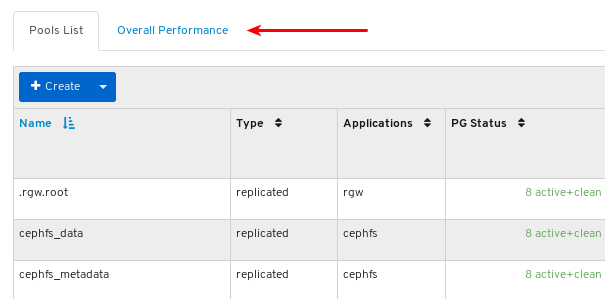

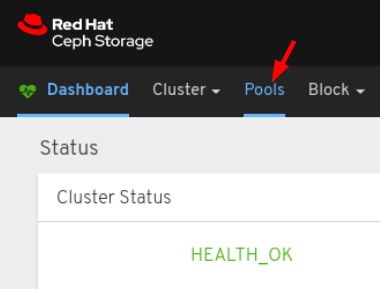

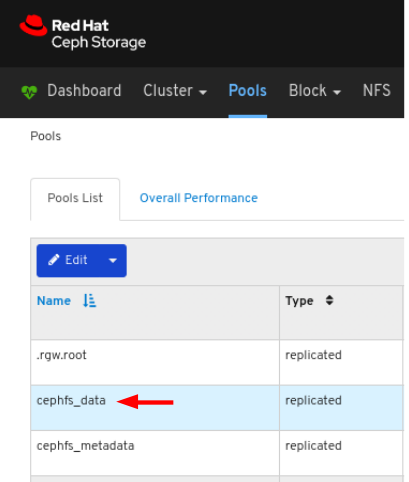

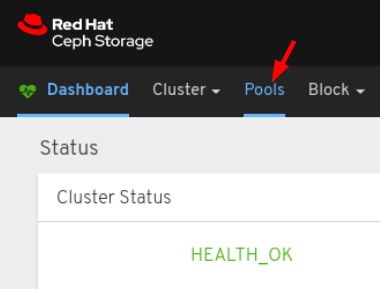

탐색 모음에서 풀을 클릭합니다.On the navigation bar, click Pools:

풀 목록을 확인합니다.

실제 사용 및 사용 가능한 공간을 볼 수 있도록 사용량 표시줄 그래프 위에 마우스를 놓습니다.

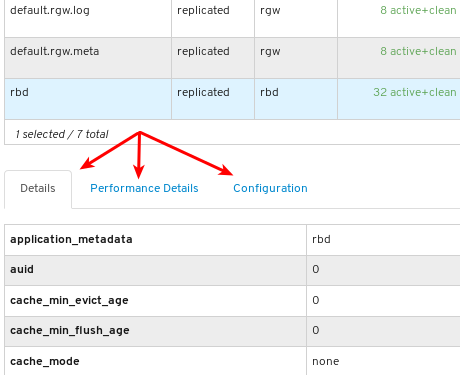

풀에 대한 자세한 정보를 보려면 행을 클릭하여 선택합니다.

풀의 세부 정보를 확인합니다. 풀의 성능 세부 정보 및 구성 데이터를 보려면 연결된 탭을 클릭합니다.

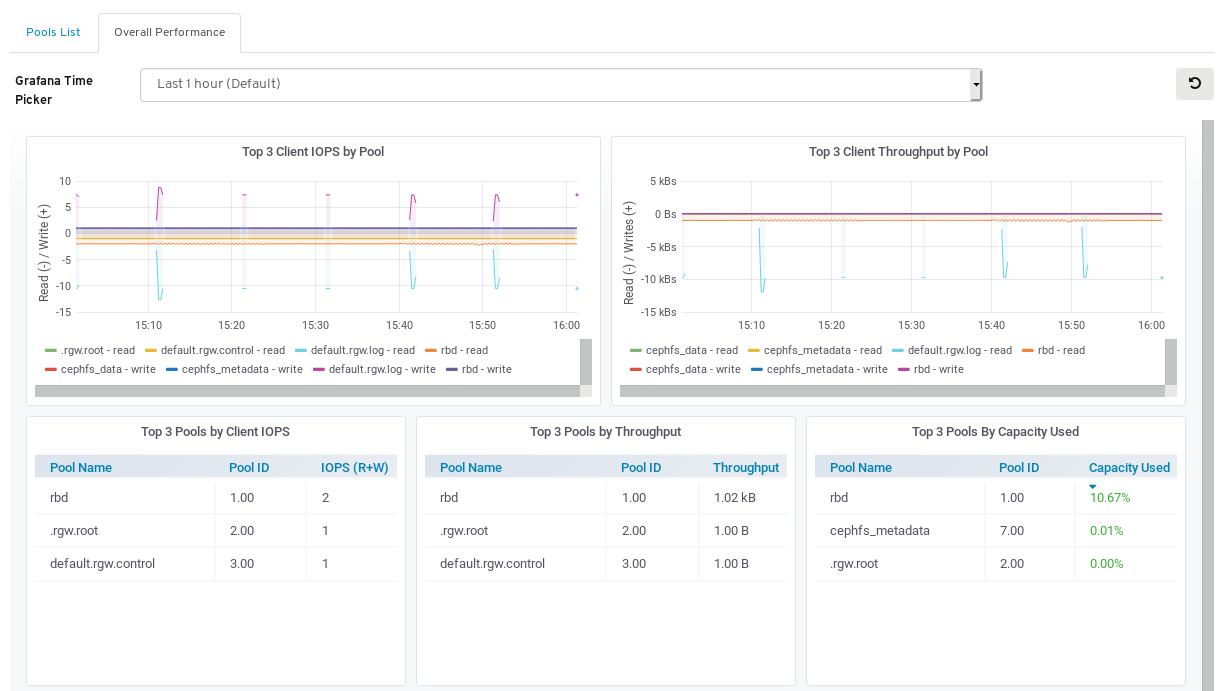

모든 풀의 성능 데이터를 보려면 페이지 왼쪽 상단에서 Overall Performance 탭을 클릭합니다.

Overall Performance 페이지 보기:

추가 리소스

- 풀에 대한 자세한 내용은 아키텍처 가이드의 풀 을 참조하십시오.

6.5. Ceph 파일 시스템 모니터링

스토리지 관리자는 Red Hat Ceph Storage 대시보드를 사용하여 Ceph File Systems(CephFS) 및 관련 구성 요소를 모니터링할 수 있습니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 대시보드가 설치됨

- Ceph 파일 시스템이 설치되어 있어야 합니다.

절차

- 대시보드에 로그인합니다.

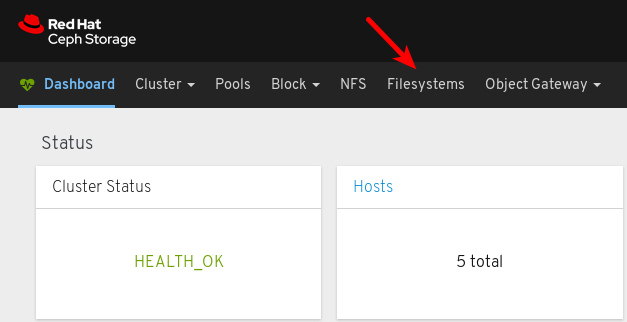

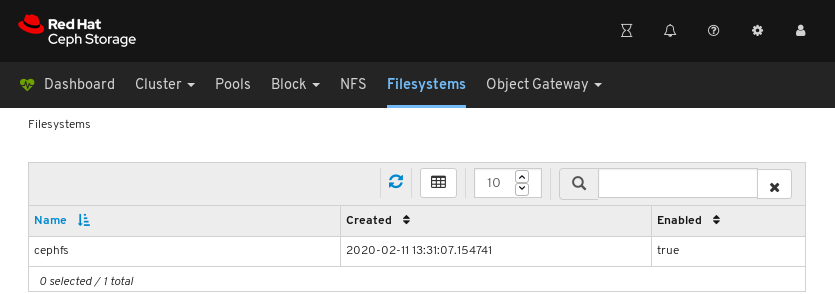

탐색 모음에서 파일 시스템을 클릭합니다.

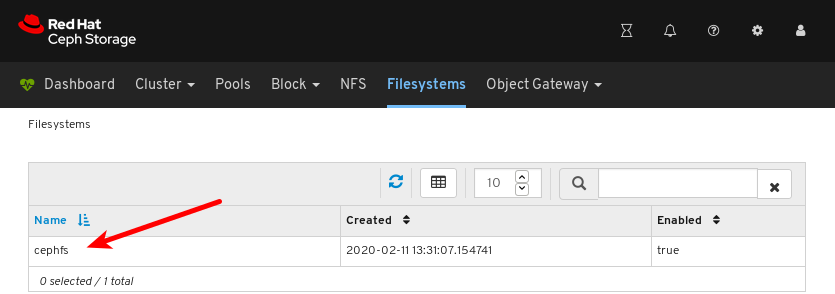

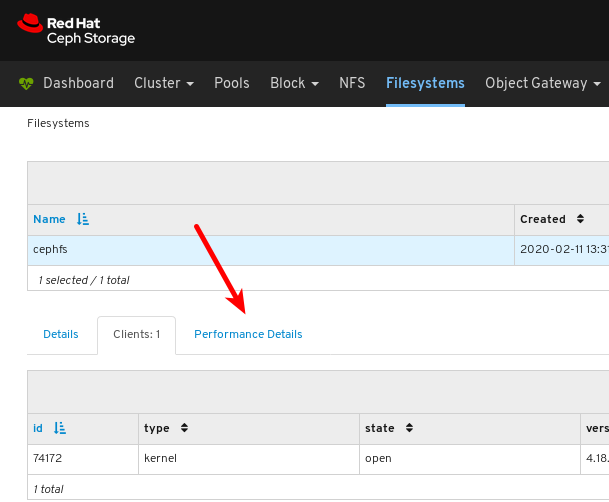

아래 예제에서는 cephfs 파일 시스템을 볼 수 있습니다.

파일 시스템의 세부 정보를 보려면 cephfs 행을 클릭합니다.

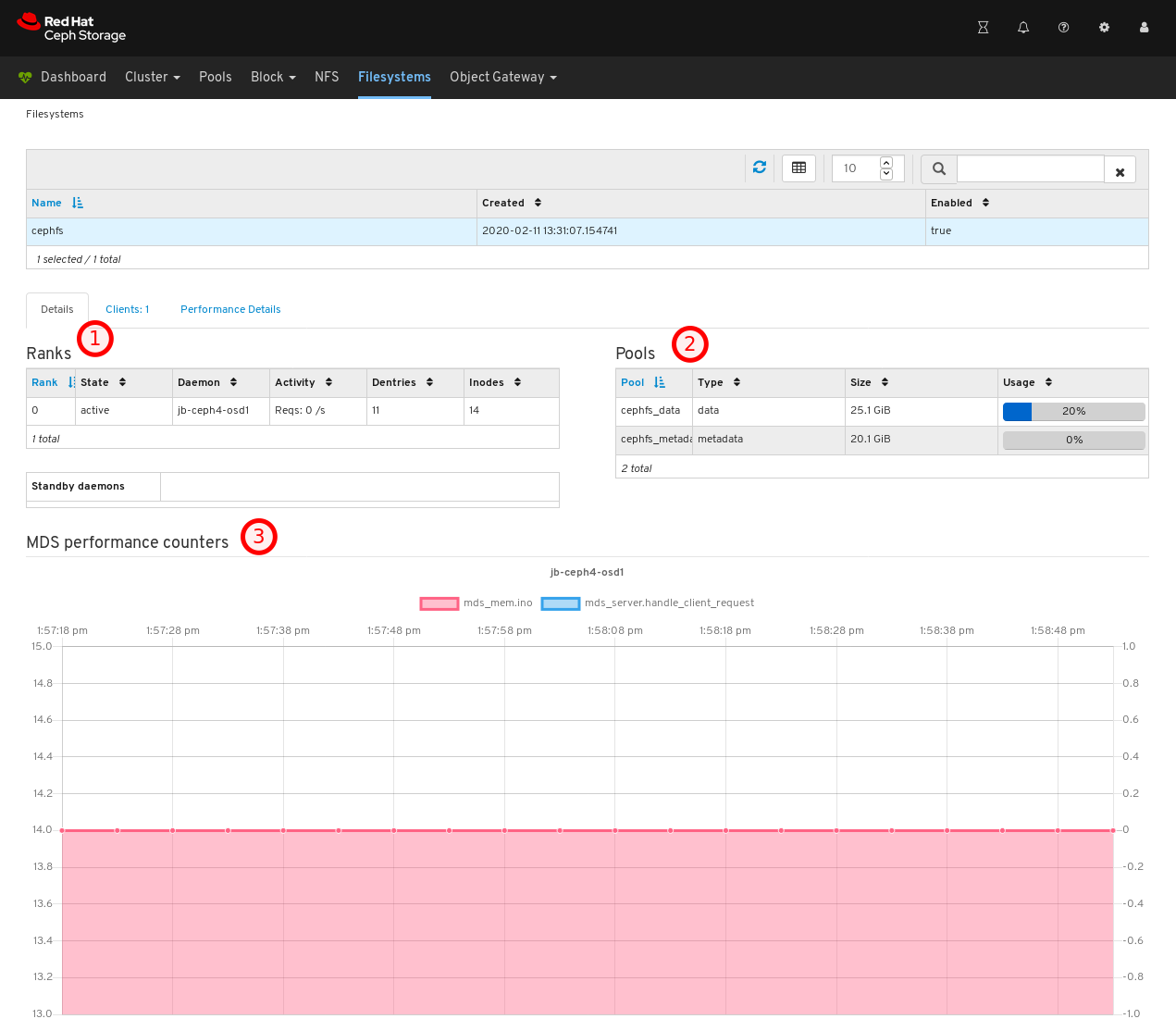

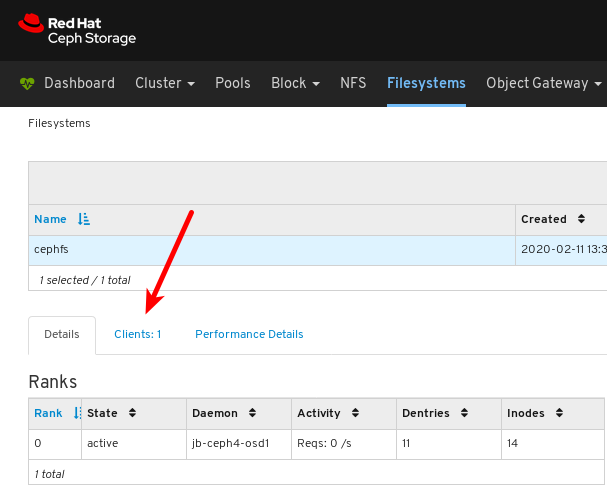

세부 정보 탭에서 메타데이터 서버와 그 순위를 1개, 풀 1 개, 풀 및 사용량에 따라 2 번, 3 개의 성능 카운터에서 볼 수 있습니다.

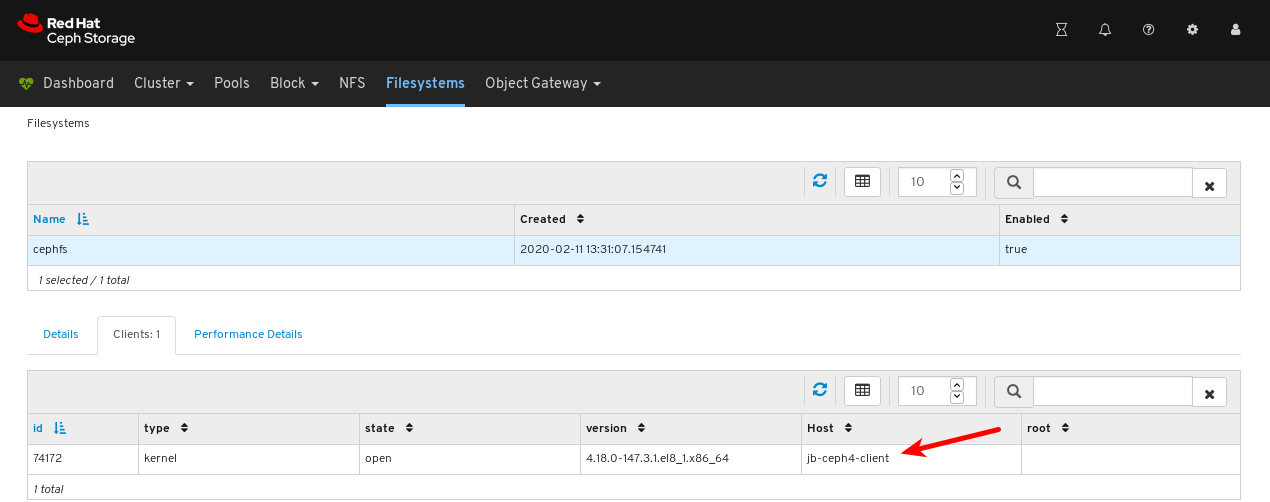

파일 시스템을 마운트한 클라이언트 목록을 보려면 클라이언트 탭을 클릭합니다.

아래 예제에서는

jb-ceph4-client호스트에 cephfs 파일 시스템이 열려 있는 것을 확인할 수 있습니다.

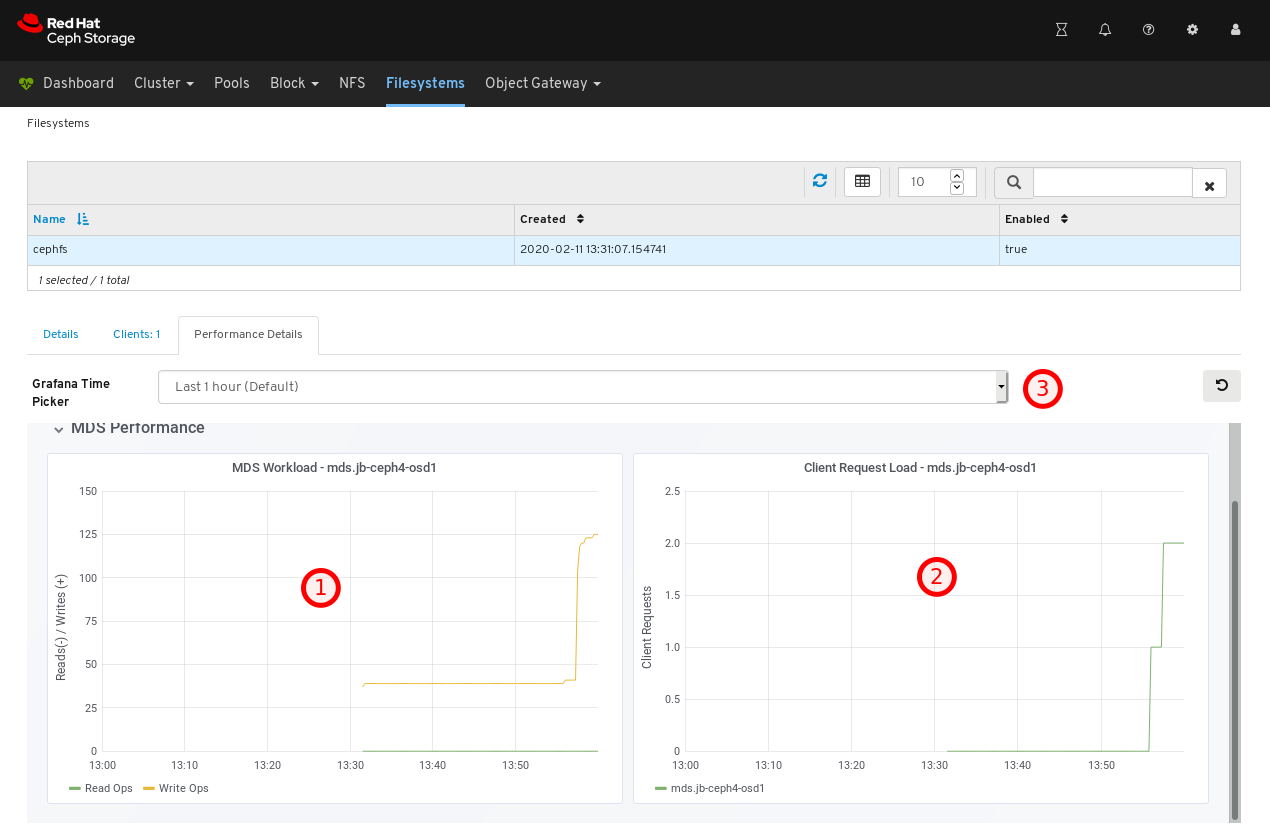

파일 시스템의 성능을 보려면 성능 세부 정보 탭을 클릭합니다.

아래 예제에서는 1 에서 클라이언트 요청 2 에서 읽기 및 쓰기 작업을 볼 수 있으며 3 에서 시간 범위를 변경할 수 있습니다.

추가 리소스

- 자세한 내용은 설치 가이드의 메타데이터 서버 설치를 참조하십시오.

- 자세한 내용은 파일 시스템 가이드 를 참조하십시오.

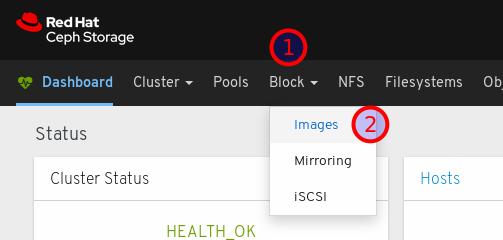

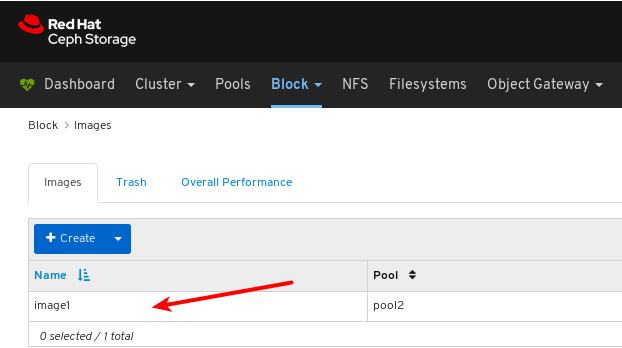

6.6. 이미지의 전체 성능 모니터링

Red Hat Ceph Storage 대시보드를 사용하면 블록에서 이미지의 전반적인 성능을 모니터링할 수 있습니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 대시보드가 설치되어 있습니다.

- RADOS 블록 장치(RBD) 풀이 생성됩니다.

- 이미지가 생성됩니다.

풀에 대해 Manager 모듈 Prometheus 내보내기가 활성화되어 있습니다.

그림 6.1. 예제

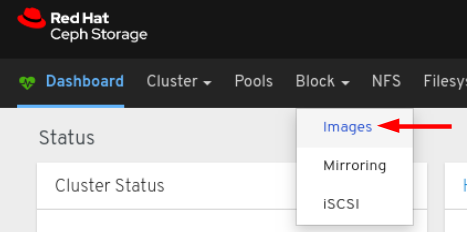

절차

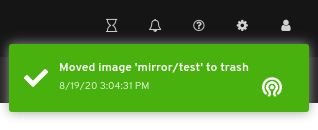

- 대시보드에 로그인합니다.

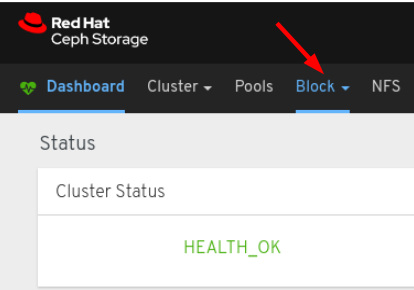

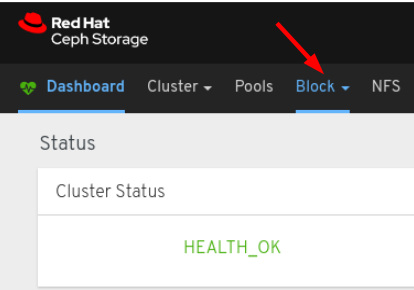

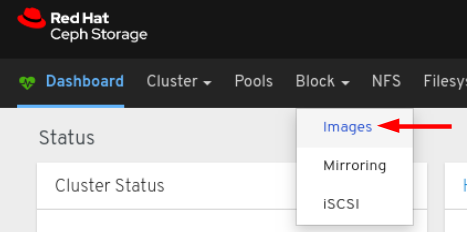

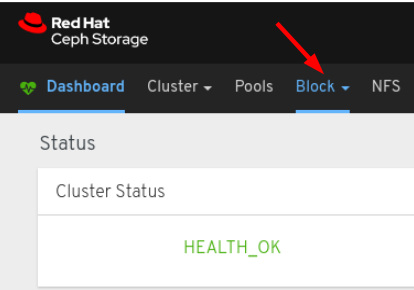

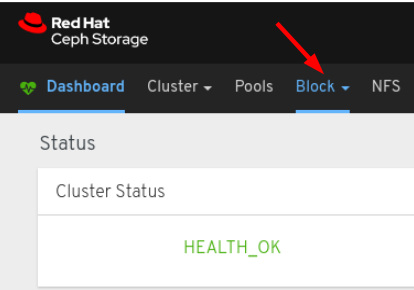

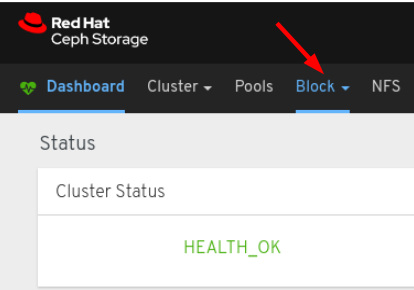

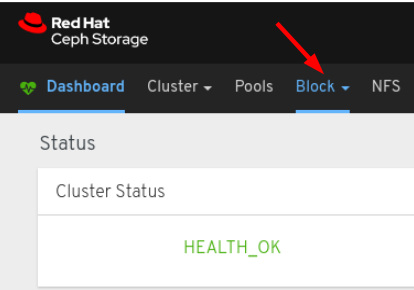

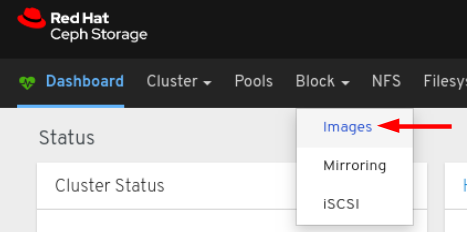

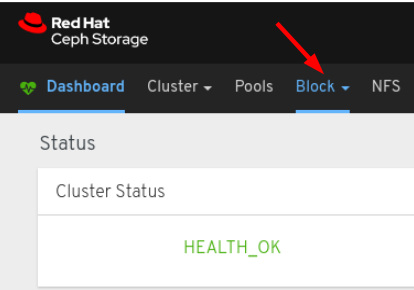

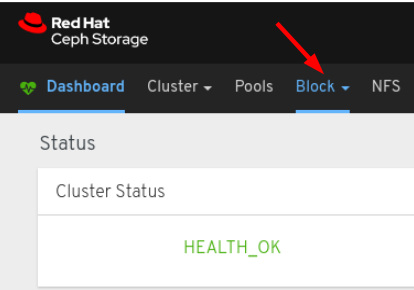

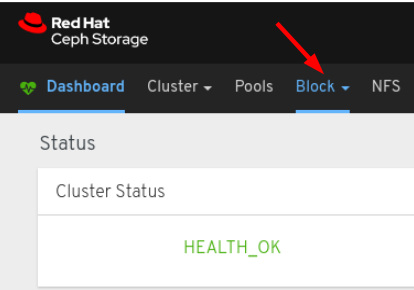

탐색 모음에서 블록을 클릭합니다.On the navigation bar, click Block:

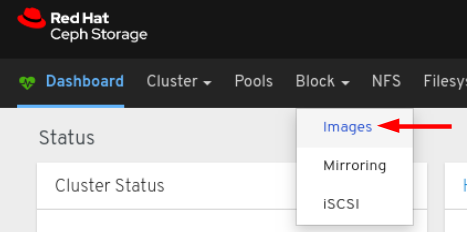

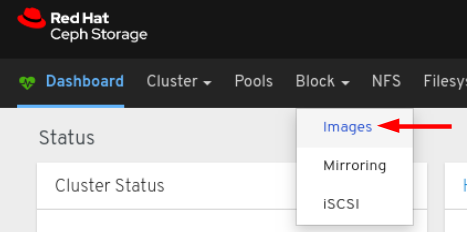

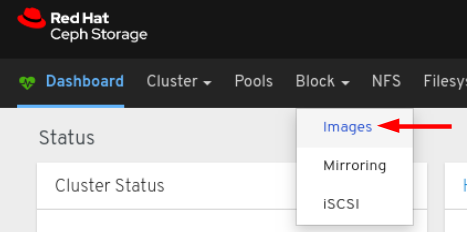

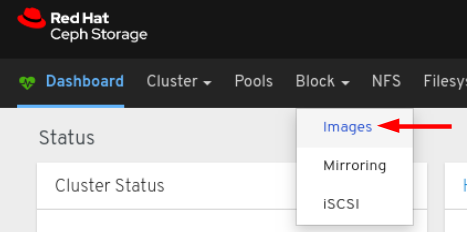

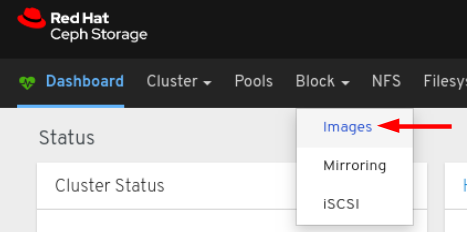

드롭다운에서 이미지를 선택합니다.

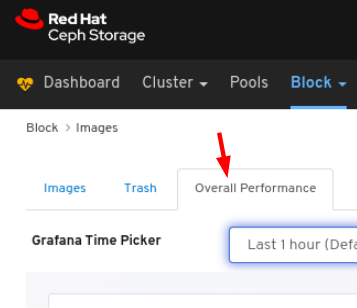

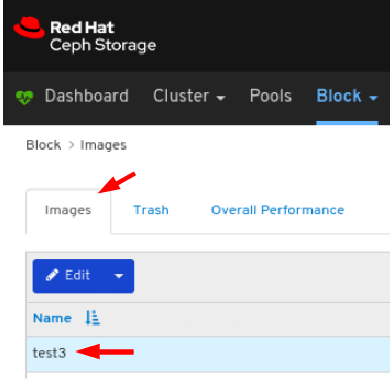

Overall Performance 탭을 선택합니다.

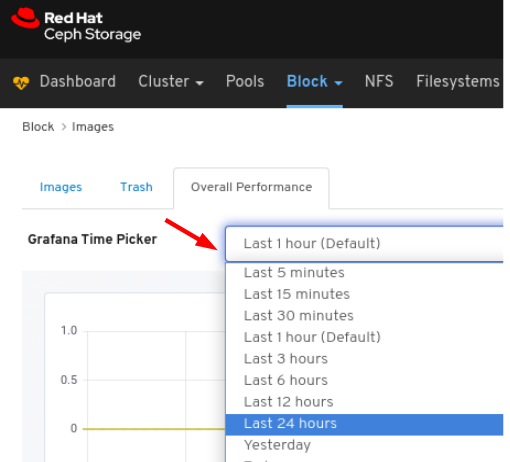

Grafana Time choosinger 드롭다운에서 시간 범위를 선택합니다.

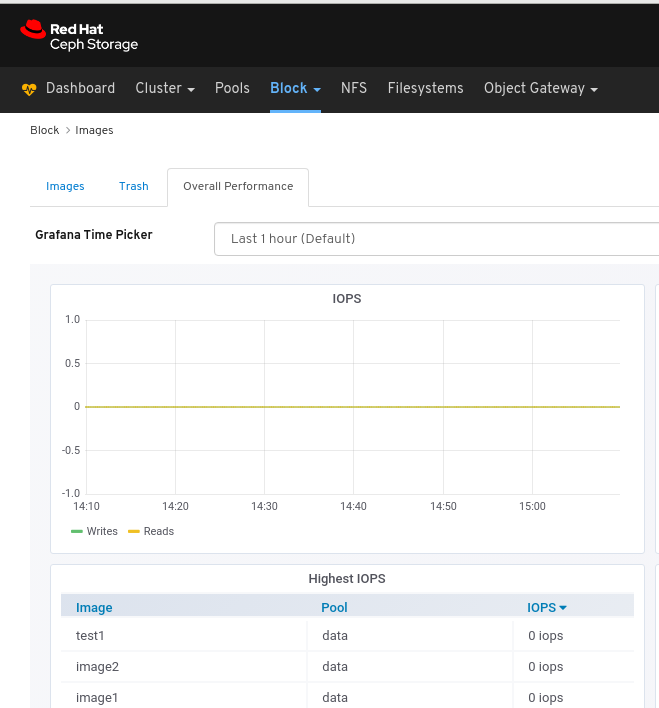

Overall Performance 페이지 보기:

7장. 클러스터 관리

7.1. 클러스터 관리

대시보드의 관리 기능을 사용하면 구성 설정을 보고 수정하고 클러스터 리소스를 관리할 수 있습니다.

7.2. CRUSH 맵 보기

CRUSH 맵에는 OSD 목록과 관련 정보가 포함되어 있습니다. CRUSH 맵과 CRUSH 알고리즘은 데이터를 저장하는 방법과 위치를 결정합니다. Red Hat Ceph Storage 대시보드를 사용하면 OSD 호스트, OSD 데몬, ID 번호, 장치 클래스 등을 포함하여 CRUSH 맵의 다양한 측면을 볼 수 있습니다.

CRUSH 맵을 사용하면 특정 OSD ID가 실행 중인 노드를 확인할 수 있습니다. OSD에 문제가 있는 경우 유용합니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 대시보드가 설치되어 있습니다.

절차

- 대시보드에 로그인합니다.

- 탐색 모음에서 클러스터를 클릭합니다.

CRUSH 맵 을 클릭합니다.

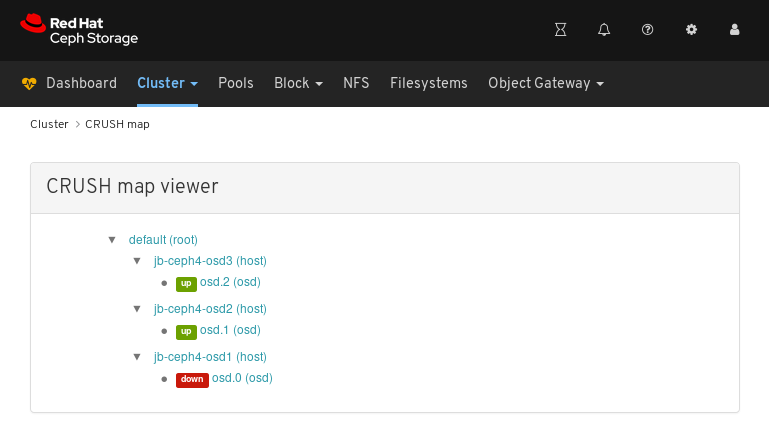

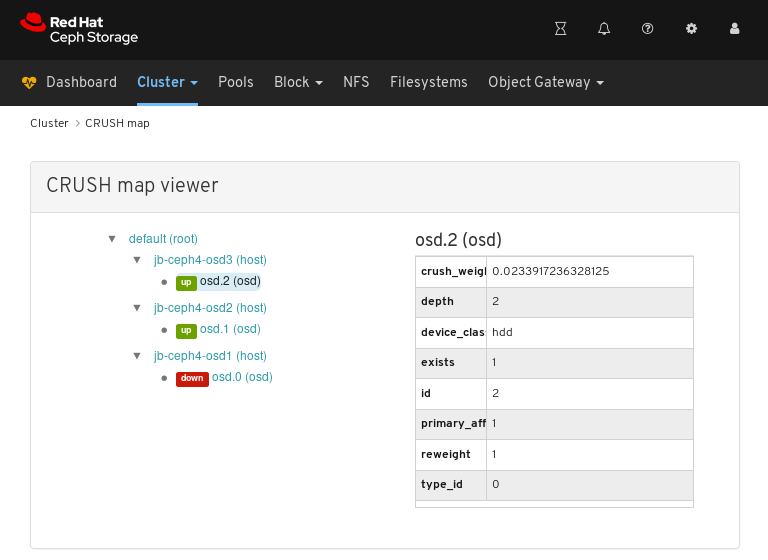

위의 예에서는 기본 CRUSH 맵, 세 개의 노드, 세 개의 노드 중 두 개에서 실행되는 OSD를 확인할 수 있습니다.

CRUSH 맵 이름, 노드 또는 OSD를 클릭하여 각 오브젝트에 대한 세부 정보를 확인합니다.

위 예제에서는

jb-rhel-osd3노드에서 실행되는 OSD와 관련된 변수 값을 확인할 수 있습니다. 특히id가2임을 유의하십시오.

추가 리소스

- CRUSH 맵에 대한 자세한 내용은 Storage 전략 가이드의 CRUSH 관리를 참조하십시오.

7.3. 관리자 모듈 구성

Red Hat Ceph Storage 대시보드를 사용하면 manager 모듈 매개 변수를 보고 구성할 수 있습니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 대시보드가 설치되어 있습니다.

절차

- 대시보드에 로그인합니다.

- 탐색 모음에서 클러스터를 클릭합니다.

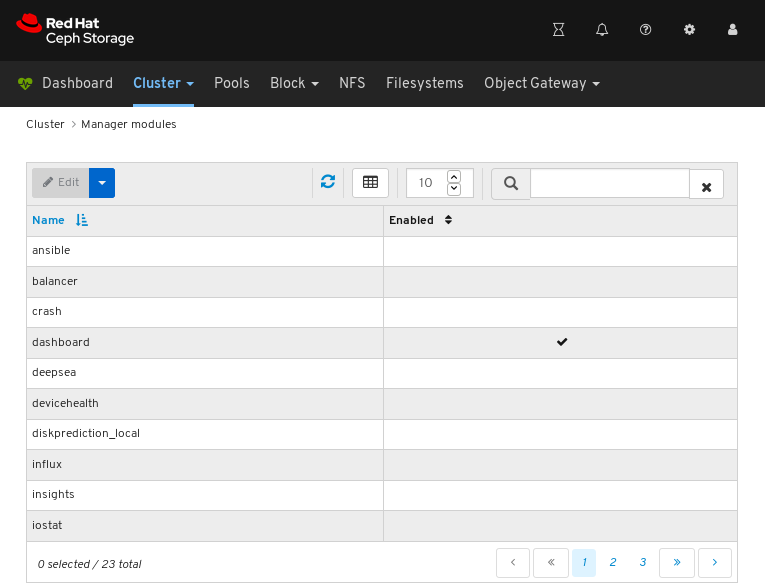

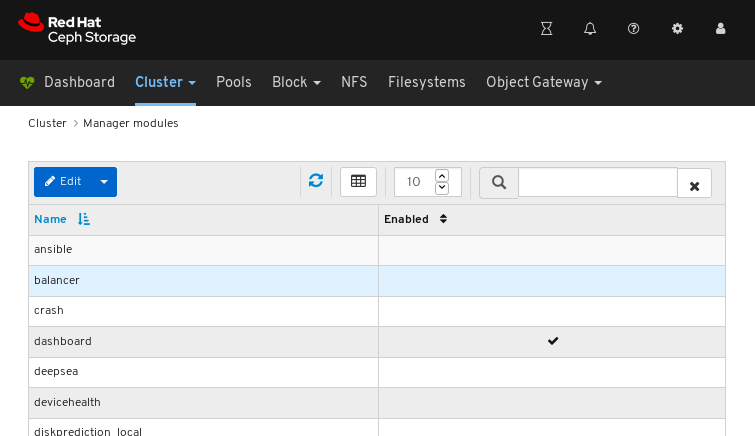

Manager 모듈을 클릭합니다.

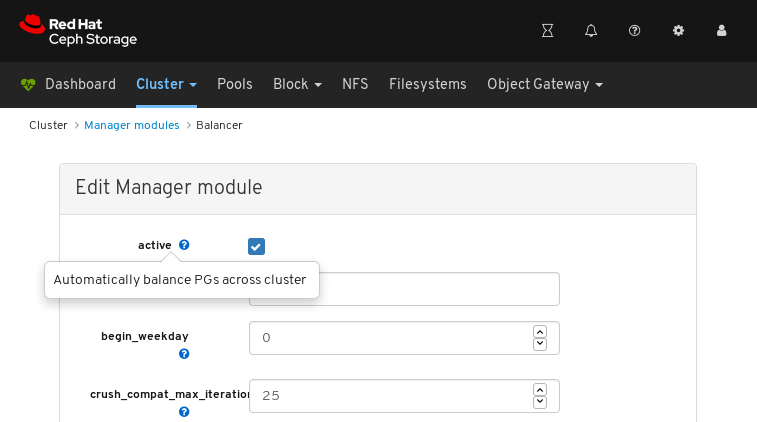

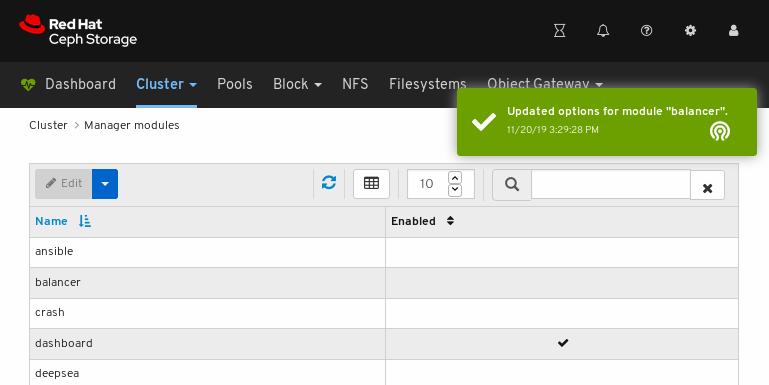

위의 스크린샷은 manager 모듈의 처음 세 페이지 중 하나를 보여줍니다.

구성할 모듈 행을 클릭합니다.

일부 모듈에는 구성 가능한 매개 변수가 있는 것은 아닙니다. 모듈을 구성할 수 없는 경우 편집 버튼이 비활성화됩니다.

페이지 왼쪽 상단에서 Edit 버튼을 클릭하여 구성 가능한 매개 변수를 사용하여 페이지를 로드합니다.

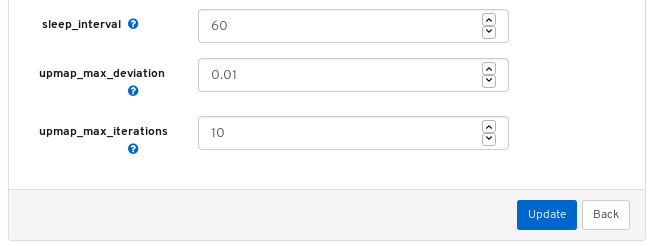

위의 스크린샷은 balancer 모듈에 대해 변경할 수 있는 매개 변수를 보여줍니다. 매개 변수에 대한 설명을 표시하려면 question mark 버튼을 클릭합니다.

매개변수를 변경하려면 매개변수 상태를 수정하고 페이지 하단에서 Update 버튼을 클릭합니다.

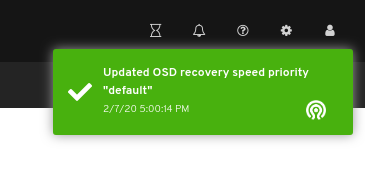

페이지 오른쪽 상단에 변경 사항이 표시되는지 확인하는 알림:

추가 리소스

- Red Hat Ceph Storage Operations Guide의 Ceph Manager 밸런서 모듈 사용을 참조하십시오.

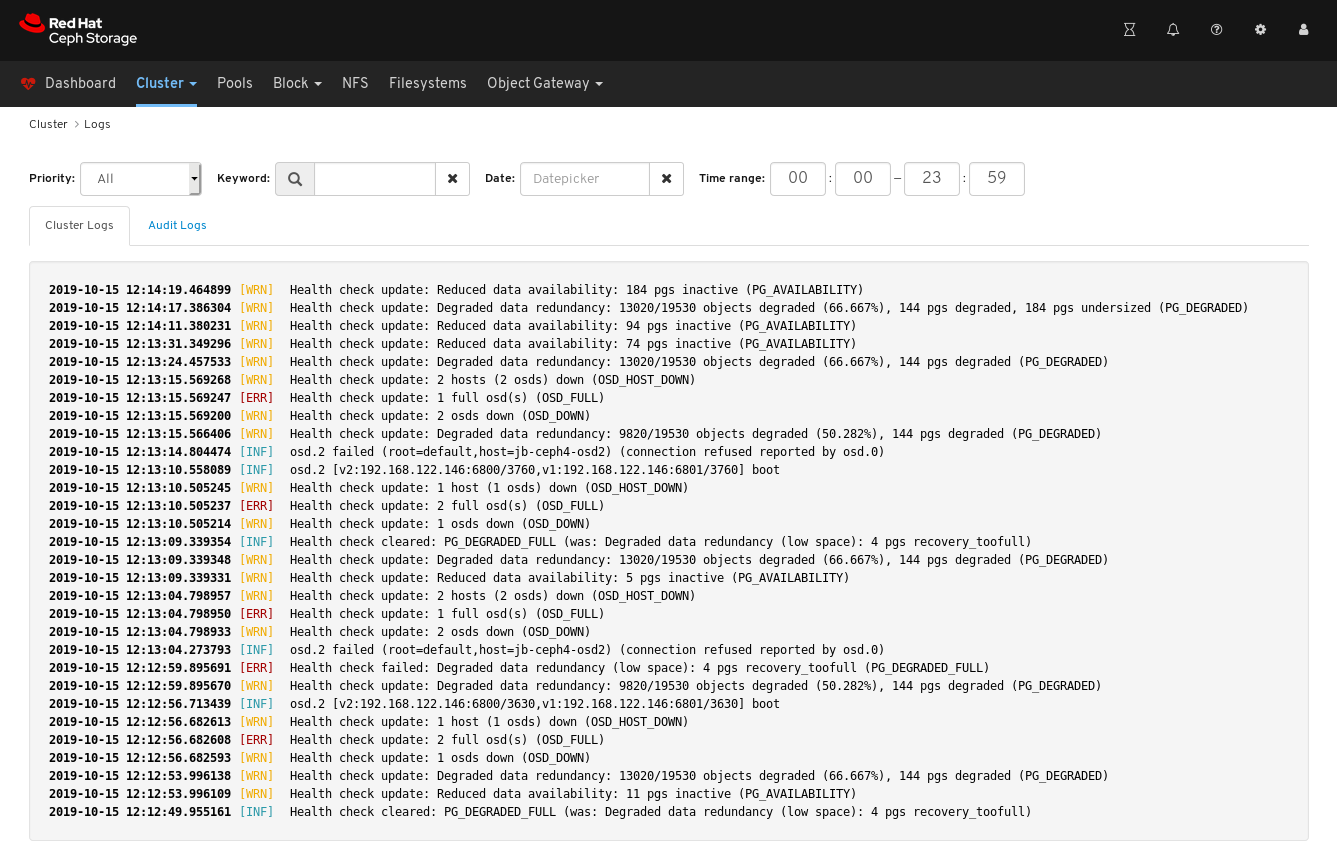

7.4. 로그 필터링

Red Hat Ceph Storage 대시보드를 사용하면 여러 기준에 따라 로그를 보고 필터링할 수 있습니다. 기준에는 우선 순위,키워드,날짜, 시간 범위가 포함됩니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 대시보드가 설치되어 있습니다.

- 모니터가 마지막으로 시작된 이후 로그 항목이 생성되었습니다.

대시보드 로깅 기능은 30개의 최신 상위 수준 이벤트만 표시합니다. 이벤트는 모니터에 의해 메모리에 저장됩니다. 모니터를 다시 시작한 후 항목이 사라집니다. 자세한 또는 이전 로그를 검토해야 하는 경우 파일 기반 로그를 참조하십시오. 파일 기반 로그에 대한 자세한 내용은 아래의 추가 리소스를 참조하십시오.

절차

- 대시보드에 로그인합니다.

-

상단 탐색 모음에서

Cluster(클러스터) 드롭다운 메뉴를 클릭합니다. -

드롭다운 메뉴에서

로그를 클릭합니다. 최근 30개의 필터링되지 않은 로그 항목을 확인합니다.

우선 순위로 필터링하려면

Priority드롭다운 메뉴를 클릭하고정보,경고또는오류중 하나를 선택합니다. 아래 예제에서는 우선 순위가Error인 로그 항목만 보여줍니다.

키워드로 필터링하려면

Keyword양식에 텍스트를 입력합니다. 아래 예제에서는osd.2텍스트를 포함하는 로그 항목만 보여줍니다.

날짜별로 필터링하려면

날짜양식을 클릭하고 날짜 선택자를 사용하여 메뉴에서 날짜를 선택하거나 YYYY-MM-DD 형식으로 날짜를 입력합니다. 아래 예제에서는 2019-15 날짜가 있는 로그 항목만 보여줍니다.

시간별로 필터링하려면 HH:MM - HH:MM - HH:MM 형식을 사용하여

시간 범위 필드에 범위를입력합니다. 시간은0에서23까지의 숫자를 사용하여 입력해야 합니다. 아래 예제에서는12:14에서12:23까지의 로그 항목만 보여줍니다.

필터를 결합하려면 두 개 이상의 필터를 설정합니다. 아래 예제에서는 우선 순위의

Warning및osd키워드가 모두 있는 항목만 보여줍니다.

추가 리소스

- 자세한 내용은 문제 해결 가이드 의 로깅 구성 섹션을 참조하십시오.

- 자세한 내용은 문제 해결 가이드 의 Ceph 로그 이해 섹션을 참조하십시오.

7.5. OSD 복구 설정 구성

스토리지 관리자는 OSD 복구 우선 순위를 변경하고 클러스터 복구 방법을 사용자 지정할 수 있습니다. 이를 통해 클러스터의 다시 빌드 성능 또는 복구 속도에 영향을 줄 수 있습니다.

사전 요구 사항

- Red Hat Ceph Storage 클러스터.

- 대시보드가 설치되어 있습니다.

절차

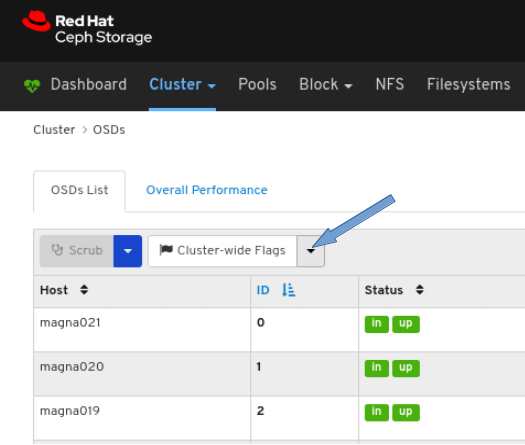

- 대시보드에 로그인합니다.

- 상단 탐색 모음에서 Cluster (클러스터) 드롭다운 메뉴를 클릭합니다.

- 드롭다운 메뉴에서 OSD 를 클릭합니다.

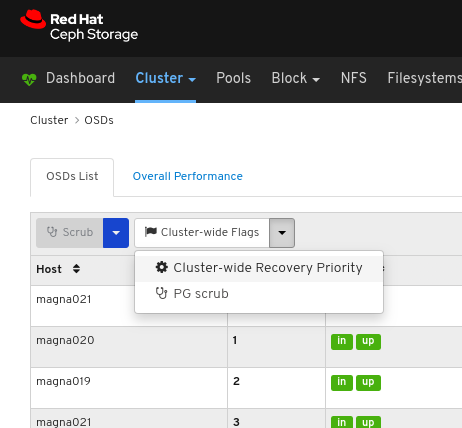

Cluster-Wide Flags 드롭다운 메뉴를 클릭합니다.

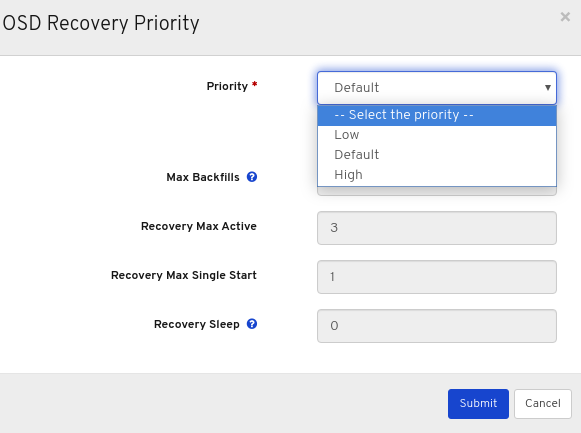

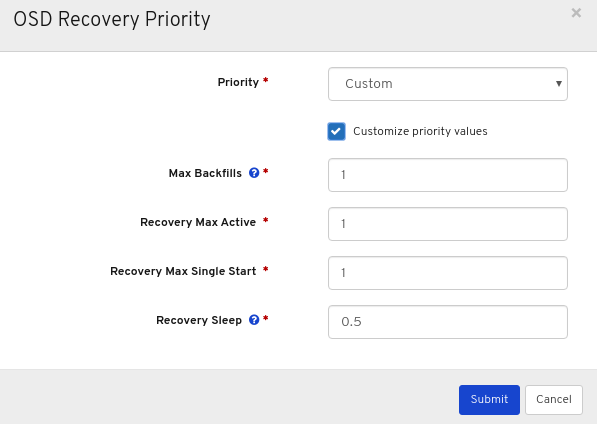

드롭다운에서 클러스터 전체 복구 우선 순위를 선택합니다.

선택 사항: 드롭다운 메뉴에서 우선 순위를 선택한 다음 Submit (제출) 버튼을 클릭합니다.

참고세 가지 사전 정의된 옵션이 있습니다: Low,Default,High

선택 사항: 우선순위 지정 값을 클릭하고 필요한 사항을 변경한 다음 Submit (제출) 버튼을 클릭합니다.

페이지 오른쪽 상단 모서리에 대한 알림은 플래그가 성공적으로 업데이트되었음을 나타냅니다.

추가 리소스

- OSD 복구에 대한 자세한 내용은 구성 가이드의 OSD 복구를 참조하십시오.

7.6. 설정 보기 및 모니터링

Red Hat Ceph Storage 대시보드를 사용하면 Ceph 클러스터에 대한 모든 구성 옵션 목록을 볼 수 있습니다. 대시보드에서 구성을 편집할 수도 있습니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 대시보드가 설치되어 있습니다.

절차

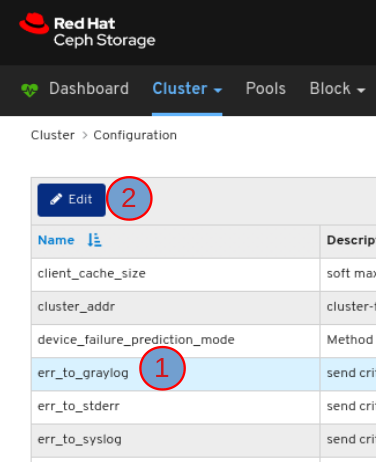

- 대시보드에 로그인합니다.

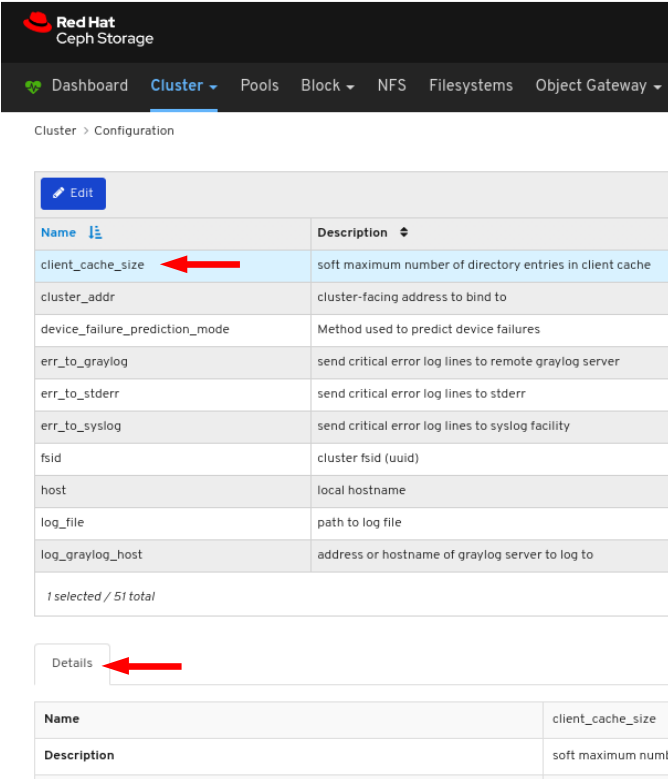

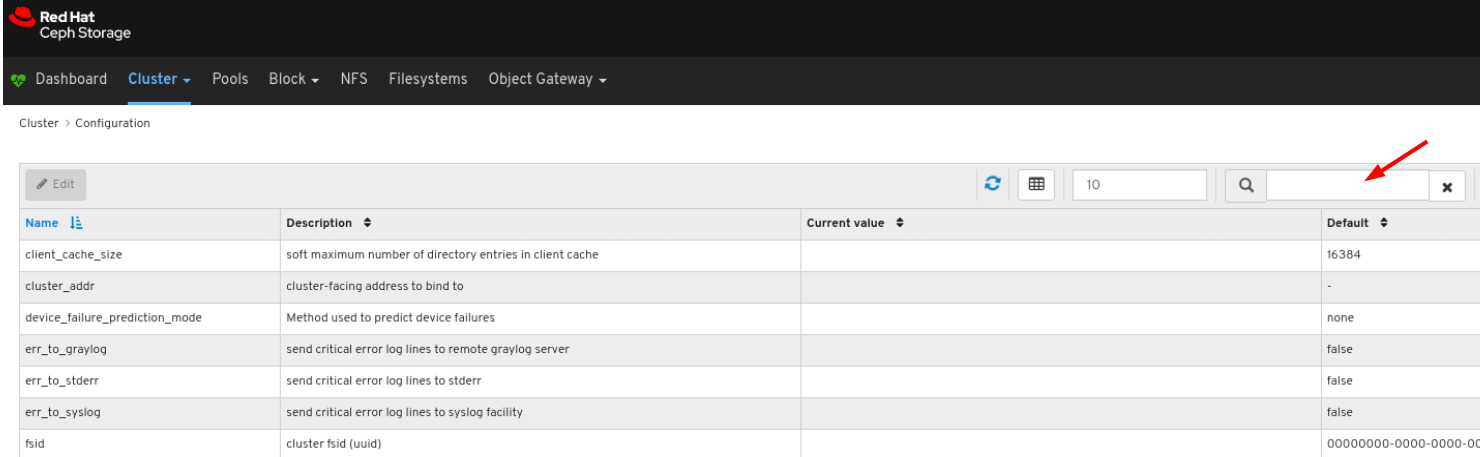

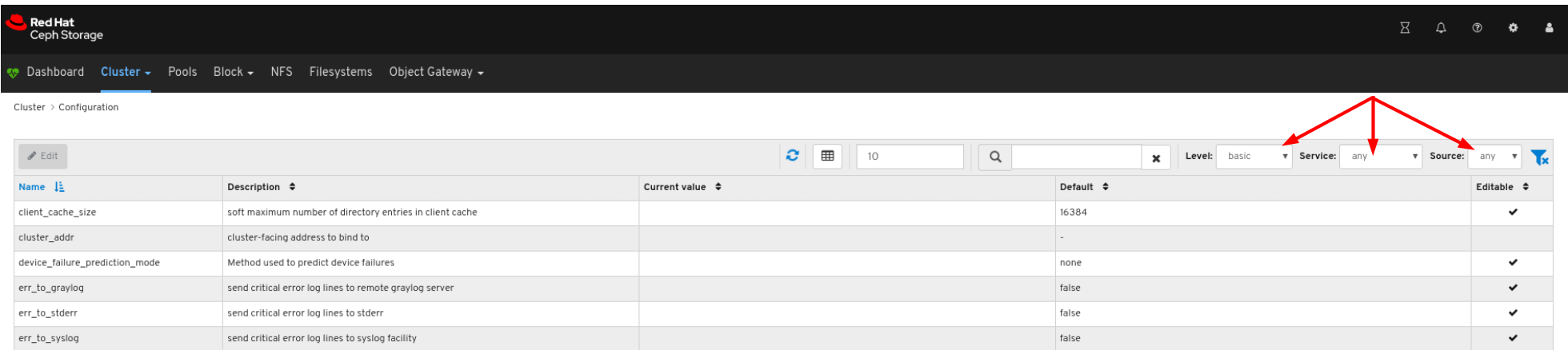

- 탐색 모음에서 클러스터를 클릭한 다음 구성을 클릭합니다.On the navigation bar, click Cluster and then click Configuration.

구성의 세부 정보를 보려면 해당 행을 클릭합니다.

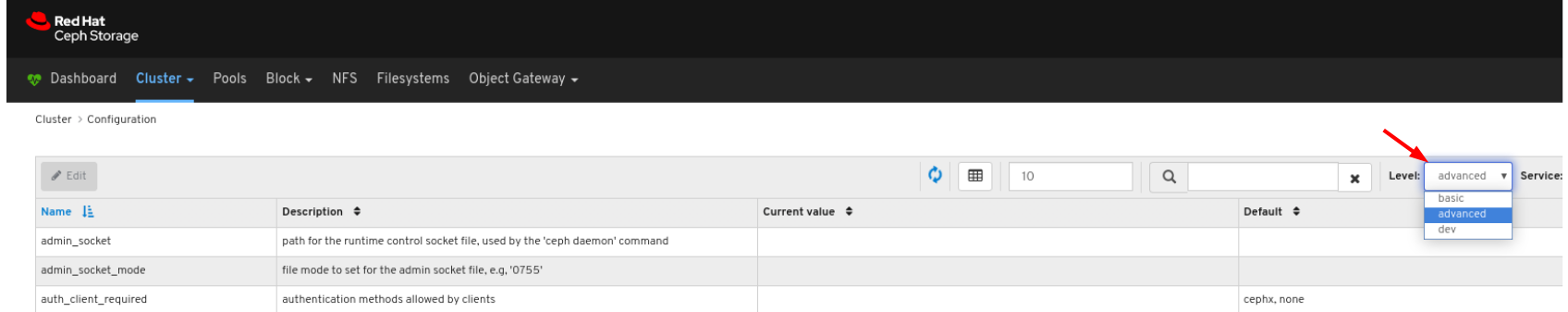

검색 상자를 사용하여 구성을 검색할 수 있습니다.

수준,서비스 또는 소스 드롭다운을 사용하여 구성을 필터링할 수 있습니다.

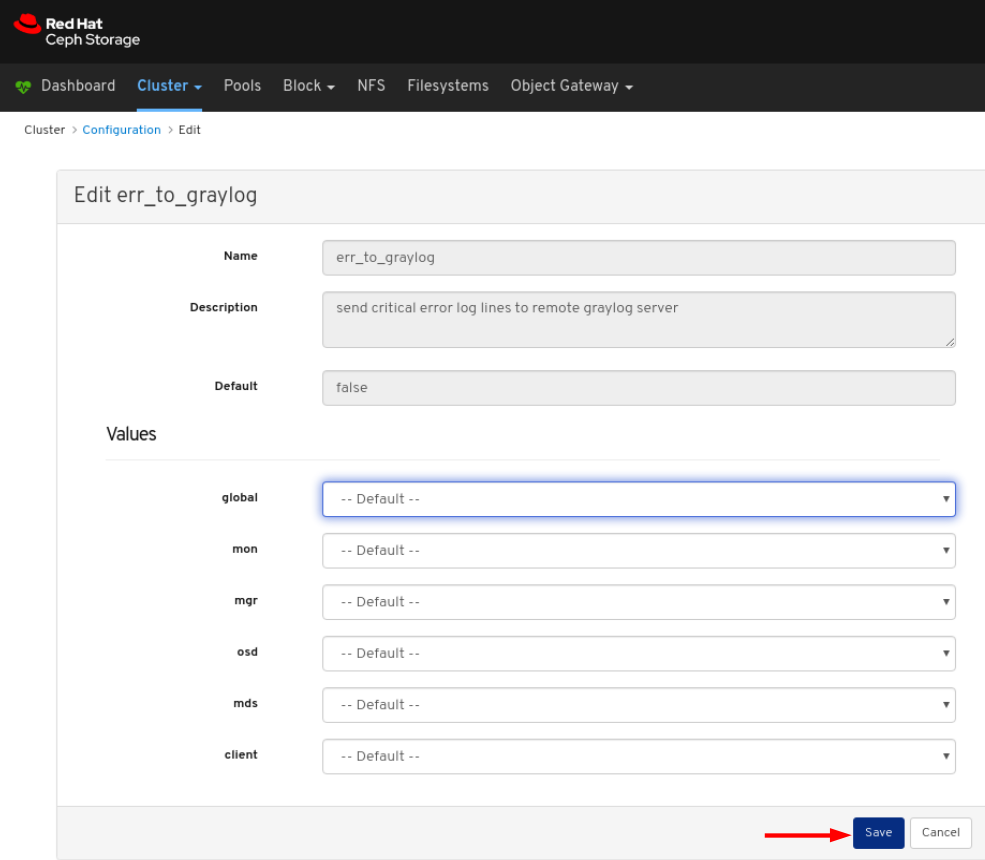

구성을 편집하려면 해당 행을 클릭하고 편집 버튼을 클릭합니다.

대화 상자 창에서 필수 매개 변수를 편집하고 저장 버튼을 클릭합니다.

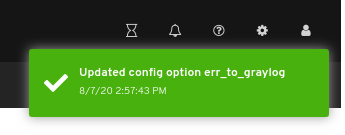

변경 사항이 페이지 오른쪽 상단에 나타나는 알림입니다.

추가 리소스

- 자세한 내용은 Red Hat Ceph Storage 구성 가이드의 Ceph 네트워크 구성 장을 참조하십시오.

7.7. Prometheus 환경 관리

Prometheus를 사용하여 Ceph 스토리지 클러스터를 모니터링하기 위해 Ceph 스토리지 클러스터에 대한 메타데이터 정보를 수집할 수 있도록 Prometheus 내보내기를 구성하고 활성화할 수 있습니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 3.1 이상 클러스터.

- Red Hat Ceph Storage 대시보드 설치.

- Red Hat Ceph Storage 대시보드 노드에 대한 루트 수준 액세스.

절차

/etc/prometheus/prometheus.yml파일을 열고 편집합니다.글로벌섹션에서scrape_interval및evaluation_interval옵션을 15초로 설정합니다.예제

global: scrape_interval: 15s evaluation_interval: 15s

scrape_configs섹션에서honor_labels: true옵션을 추가하고 각ceph-mgr노드에 대한대상및인스턴스옵션을 편집합니다.예제

scrape_configs: - job_name: 'node' honor_labels: true static_configs: - targets: [ 'node1.example.com:9100' ] labels: instance: "node1.example.com" - targets: ['node2.example.com:9100'] labels: instance: "node2.example.com"참고honor_labels옵션을 사용하면 Ceph 스토리지 클러스터의 모든 노드와 관련된 적절하게 레이블이 지정된 데이터를 출력할 수 있습니다. 이를 통해 Ceph는 Prometheus가 덮어쓰지 않고 적절한인스턴스레이블을 내보낼 수 있습니다.새 노드를 추가하려면

대상및인스턴스옵션을 다음 형식으로 추가하기만 하면 됩니다.예제

- targets: [ 'new-node.example.com:9100' ] labels: instance: "new-node"참고인스턴스레이블은 노드의 짧은 호스트 이름인 Ceph의 OSD 메타데이터인스턴스필드에 표시되는 항목과 일치해야 합니다. 이를 통해 Ceph 통계와 노드 통계의 상관 관계를 유지하는 데 도움이 됩니다.

다음 형식의

/etc/prometheus/ceph_targets.yml파일에 Ceph 대상을 추가합니다.예제

[ { "targets": [ "cephnode1.example.com:9283" ], "labels": {} } ]Prometheus 모듈을 활성화합니다.

[root@mon ~]# ceph mgr module enable prometheus

7.8. grafana-server 및 Prometheus 복원

grafana-server에는 Grafana UI, Prometheus, 컨테이너, Red Hat Ceph Storage 구성이 포함됩니다. grafana-server가 충돌하거나 결함이 있는 경우 파일을 백업하고 백업 파일을 사용하여 복원하여 복원할 수 있습니다. Prometheus의 경우 외부 백업을 가져온 다음 데이터를 복원할 수 있습니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- Grafana 노드에 대한 루트 수준 액세스.

절차

Grafana 데이터베이스의 백업을 가져옵니다.

grafana-server 노드에서 Grafana 서비스를 중지합니다.

예제

[root@node04 ~]# systemctl stop grafana-server.service [root@node04 ~]# systemctl status grafana-server.service

Grafana 데이터베이스의 백업을 가져옵니다.

예제

[root@node04 ~]# cp /var/lib/grafana/grafana.db /var/lib/grafana/grafana_backup.db

grafana-server 노드에서 Grafana 서비스를 다시 시작합니다.

예제

[root@node04 ~]# systemctl restart grafana-server.service

grafana-server를 복원합니다.

grafana-server 노드에서 Grafana 서비스가 실행 중인 경우 서비스를 중지합니다.

예제

[root@node04 ~]# systemctl stop grafana-server.service [root@node04 ~]# systemctl status grafana-server.service

백업된

grafana.db파일을/var/lib/grafana/디렉터리로 이동합니다.예제

[root@node04 ~]# mv /var/lib/grafana/grafana_backup.db /var/lib/grafana/

grafana-server 노드에서 Grafana 서비스를 다시 시작합니다.

예제

[root@node04 ~]# systemctl restart grafana-server.service

Prometheus 경고의 경우 기본적으로 Ceph-Ansible 설정은

var/lib/prometheus디렉터리인prometheus_data_dir디렉터리의 외부 백업을 가져와서 백업 디렉터리를 사용하여 서비스를 복원해야 합니다.grafana-server 노드에서 Prometheus 서비스를 중지합니다.

예제

[root@node04 ~]# systemctl stop prometheus.service [root@node04 ~]# systemctl status prometheus.service

기본 Prometheus 디렉터리를 백업합니다.

예제

[root@node04 ~]# cp /var/lib/prometheus/ /var/lib/prometheus_backup/

prometheus_data_dir디렉터리를 backed-up 디렉터리로 바꿉니다.예제

[root@node04 ~]# mv /var/lib/prometheus_backup/ /var/lib/prometheus_data_dir

grafana-server 노드에서 prometheus 서비스를 다시 시작합니다.

예제

[root@node04 ~]# systemctl restart prometheus.service [root@node04 ~]# systemctl status prometheus.service

참고group_vars/all.yml파일의 Prometheus 매개변수를 변경한 경우 플레이북을 재실행해야 합니다.

선택 사항: 변경 사항이 Red Hat Ceph Storage 대시 보드에 반영되지 않는 경우 대시보드를 비활성화한 다음 활성화해야 합니다.

예제

[root@node04 ~]# ceph mgr module disable dashboard [root@node04 ~]# ceph mgr module enable dashboard

7.9. 경고 보기 및 관리

스토리지 관리자는 Red Hat Ceph Storage 대시보드에서 경고 세부 정보를 확인하고 경고에 대한 음소거를 생성할 수 있습니다. 여기에는 다음과 같은 사전 정의 경고가 포함됩니다.

- OSD 다운

- Ceph 상태 오류

- Ceph 상태 경고

- 클러스터 용량 낮음

- Disk(s)ear Full(s) Near Full

- MON(s) Down

- 네트워크 오류

- OSD 호스트 손실 확인

- OSD 호스트 다운

- High PG 수가 있는 OSD

- PG(s) Stuck

- 풀 용량 낮음

- OSD 응답 속도 저하

7.9.1. 경고 보기

경고가 실행되면 Red Hat Ceph Storage 대시보드에서 이를 볼 수 있습니다. 또한 대시보드를 활성화하여 경고에 대한 이메일을 보낼 수 있습니다.

Red Hat Ceph Storage 4 클러스터에서는 SMTP(Simple mail transfer protocol) 및 SSL이 지원되지 않습니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 대시보드가 설치되어 있습니다.

- 경고가 실행됩니다.

절차

- 대시보드에 로그인합니다.

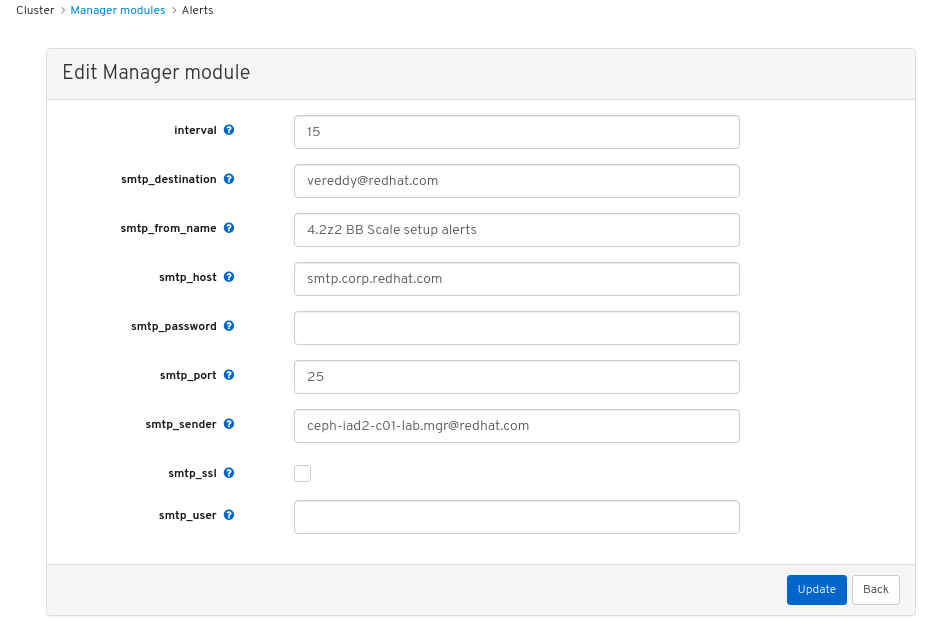

대시보드에서 alerts 모듈을 사용자 지정하여 스토리지 클러스터에 대한 이메일 경고를 가져옵니다.

- 탐색 모음에서 클러스터를 클릭합니다.

- Manager 모듈을 선택합니다.

- alerts 모듈을 선택합니다.

- 편집 드롭다운 메뉴에서 편집을 선택합니다.

Edit Manager 모듈에서 필요한 매개 변수를 업데이트하고 업데이트를 클릭합니다.

그림 7.1. 경고에 대한 관리자 모듈 편집

- 탐색 모음에서 클러스터를 클릭합니다.

- 드롭다운 메뉴에서 Monitoring 을 선택합니다.

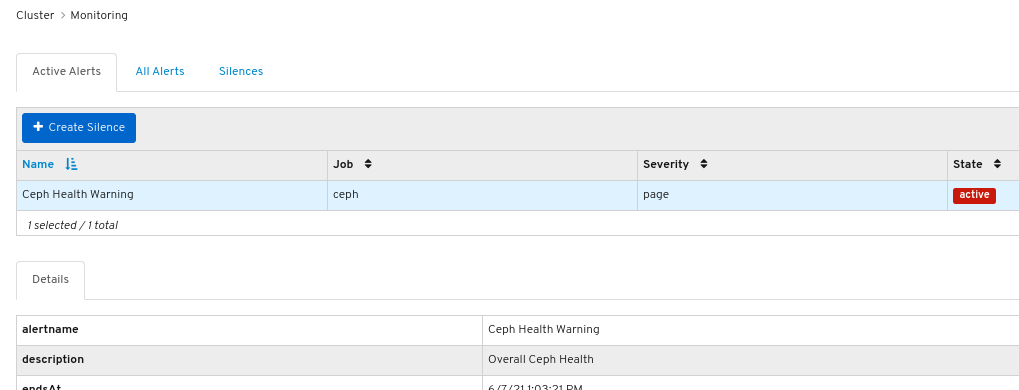

경고에 대한 세부 정보를 보려면 해당 행을 클릭합니다.

그림 7.2. 경고 세부 정보

- 경고 소스를 보려면 해당 행을 클릭한 다음 소스를 클릭합니다.

7.9.2. 음소거 생성

Red Hat Ceph Storage Dashboard에서 지정된 시간 동안 경고에 대한 음소거를 생성할 수 있습니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 대시보드가 설치되어 있습니다.

- 경고가 실행됩니다.

절차

- 대시보드에 로그인합니다.

- 탐색 모음에서 클러스터를 클릭합니다.

- 드롭다운 메뉴에서 Monitoring 을 선택합니다.

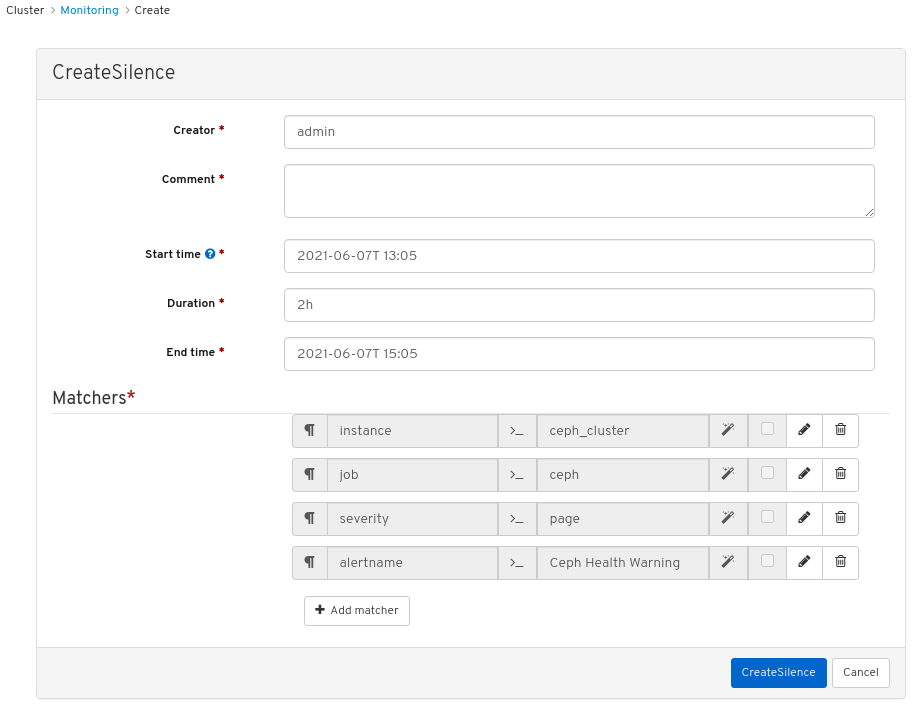

- 경고 행을 클릭한 다음 +Create Silence 를 클릭합니다.

CreateSilence 창에서 Duration 에 대한 세부 정보를 추가하고 음소거 생성을 클릭합니다.

그림 7.3. 음소거 생성

- 음소거가 성공적으로 생성되었다는 통지를 받습니다.

7.9.3. 음소거 다시 생성

Red Hat Ceph Storage 대시보드의 만료된 음소거에서 음소거를 다시 생성할 수 있습니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 대시보드가 설치되어 있습니다.

- 경고가 실행됩니다.

- 경고용으로 생성된 음소거입니다.

절차

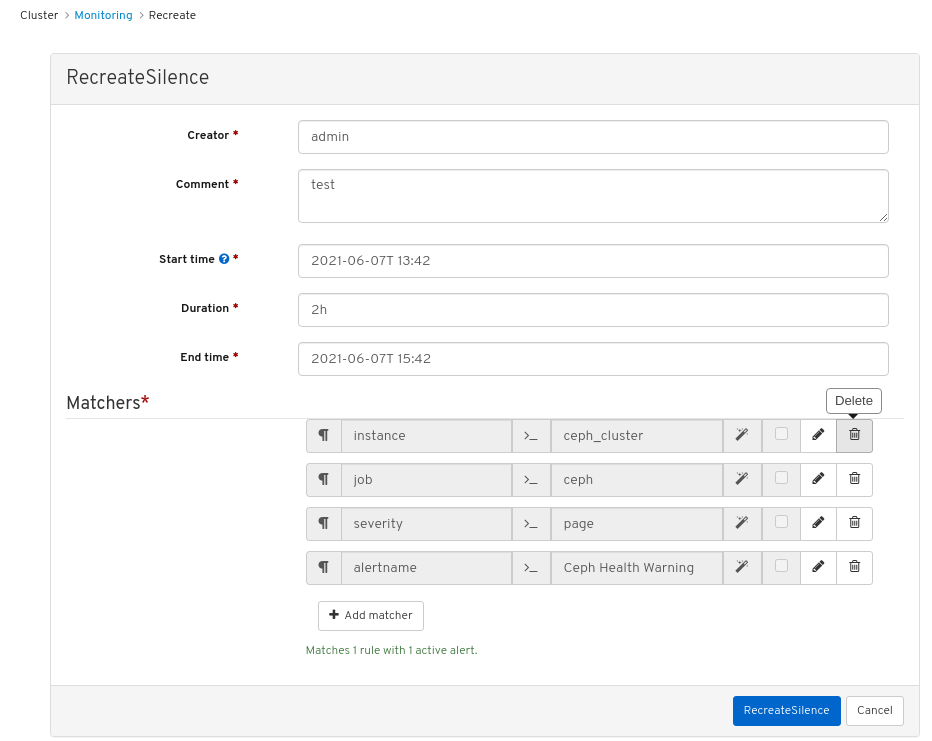

- 대시보드에 로그인합니다.

- 드롭다운 메뉴에서 Monitoring 을 선택합니다.

- 음소거 탭을 클릭합니다.

- 만료된 음소거 행을 클릭합니다.

- 재생성 버튼을 클릭합니다.

RecreateSilence 창에서 세부 사항을 추가하고 RecreateSilence 를 클릭합니다.

그림 7.4. 재현 음소거

- 음소거가 성공적으로 다시 생성되었음을 알리는 알림을 받습니다.

7.9.4. 음소거 편집

예를 들어 Red Hat Ceph Storage 대시보드에서 활성화된 시간을 연장하기 위해 활성 음소거를 편집할 수 있습니다. 음소거가 만료된 경우 음소거를 다시 생성하거나 경고에 대한 새 음소거를 생성할 수 있습니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 대시보드가 설치되어 있습니다.

- 경고가 실행됩니다.

- 경고용으로 생성된 음소거입니다.

절차

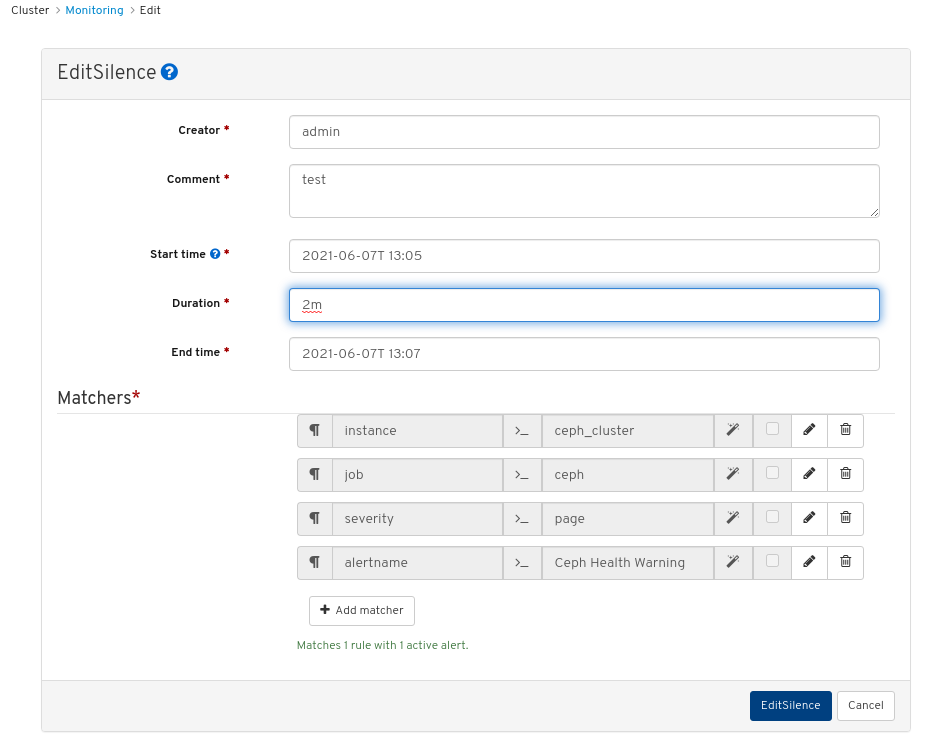

- 대시보드에 로그인합니다.

- 탐색 모음에서 클러스터를 클릭합니다.

- 드롭다운 메뉴에서 Monitoring 을 선택합니다.

- 음소거 탭을 클릭합니다.

- 음소거 행을 클릭합니다.

- 편집 드롭다운 메뉴에서 편집 을 선택합니다.

EditSilence 창에서 세부 정보를 업데이트하고 음소거 편집 을 클릭합니다.

그림 7.5. 음소거 편집

- 음소거가 성공적으로 업데이트되었음을 알리는 알림을 받습니다.

7.9.5. 음소거 만료

Red Hat Ceph Storage Dashboard에서 일치하는 경고가 비활성화되도록 음소거를 만료할 수 있습니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 대시보드가 설치되어 있습니다.

- 경고가 실행됩니다.

- 경고용으로 생성된 음소거입니다.

절차

- 대시보드에 로그인합니다.

- 탐색 모음에서 클러스터를 클릭합니다.

- 드롭다운 메뉴에서 Monitoring 을 선택합니다.

- 음소거 탭을 클릭합니다.

- 음소거 행을 클릭합니다.

- 편집 드롭다운 메뉴에서 Expire 를 선택합니다.

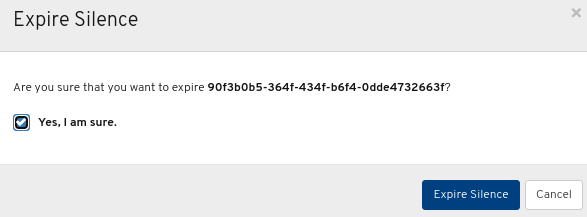

음소거 만료 대화 상자에서 예, 확신이 확인되고 Expire Silence 를 클릭합니다.

그림 7.6. 만료일

- 음소거가 성공적으로 만료되었다는 통지를 받습니다.

7.9.6. 추가 리소스

- 자세한 내용은 Red Hat Ceph StorageTroubleshooting Guide 를 참조하십시오.

7.10. 풀 관리

스토리지 관리자는 풀을 생성, 삭제 및 편집할 수 있습니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 대시보드가 설치됨

7.10.1. 풀 생성

풀을 생성하여 스토리지 오브젝트를 논리적으로 분할할 수 있습니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 대시보드가 설치되어 있습니다.

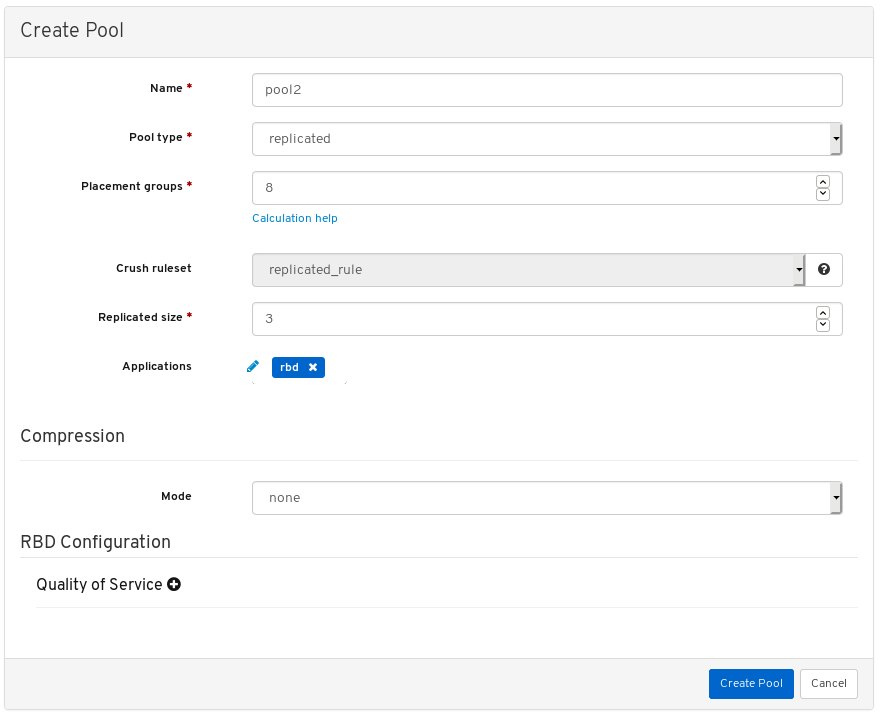

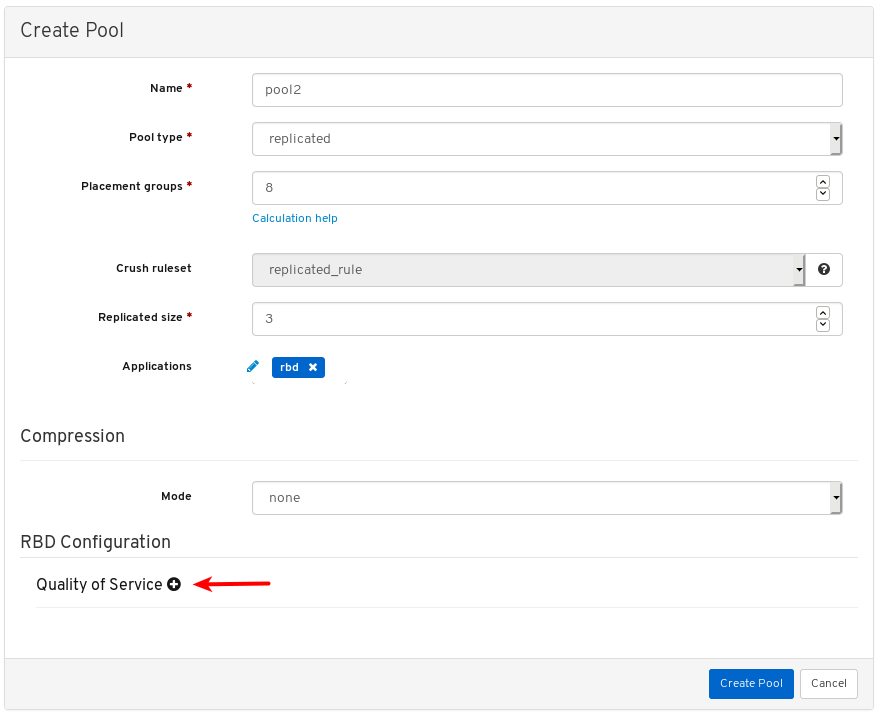

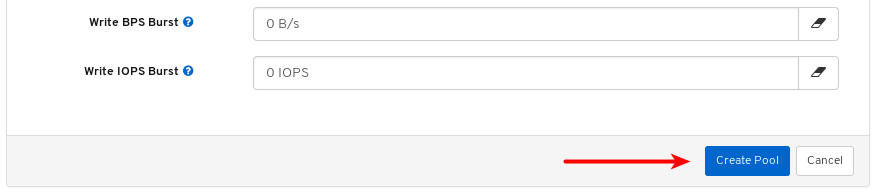

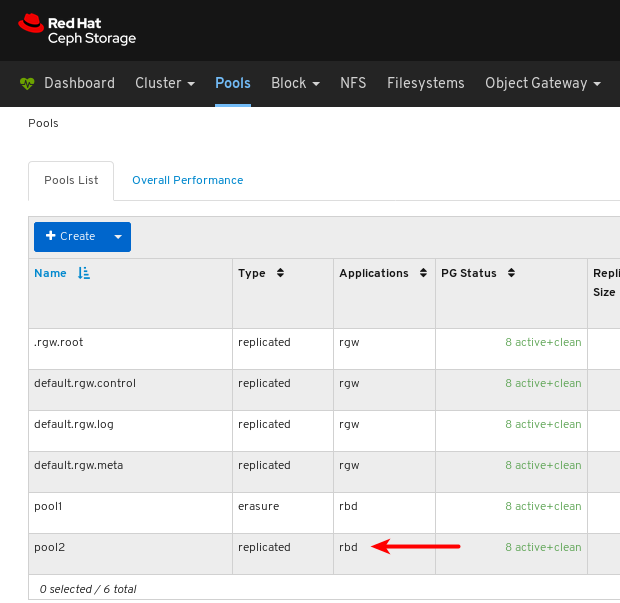

절차

- 대시보드에 로그인합니다.

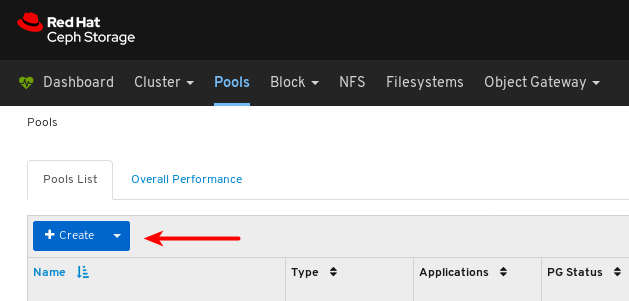

탐색 모음에서 풀 을 클릭합니다.

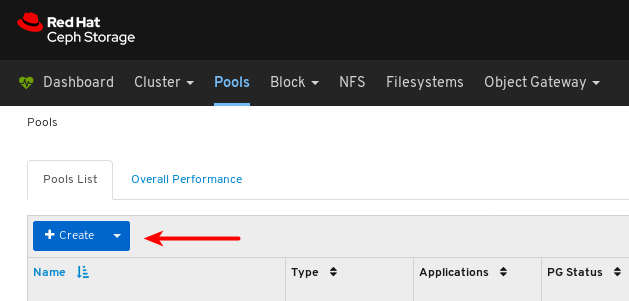

페이지 왼쪽 상단 모서리에 있는 Create (생성) 버튼을 클릭합니다.

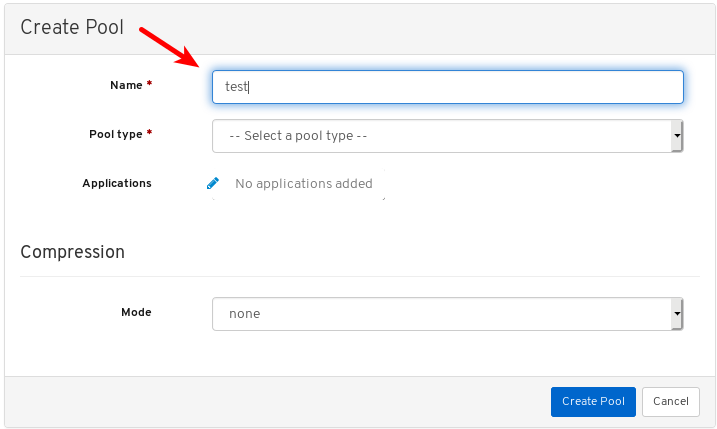

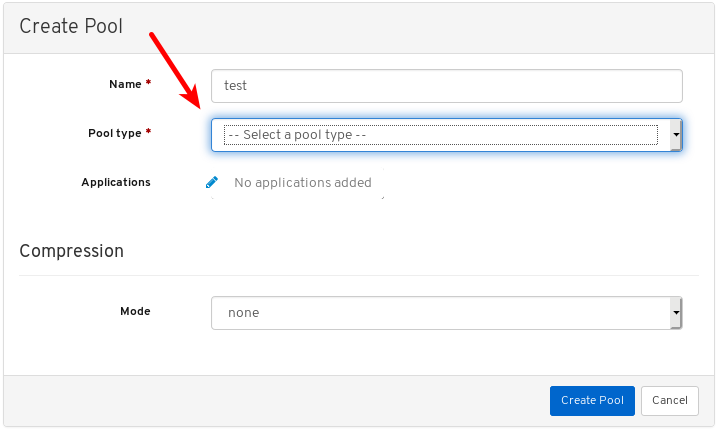

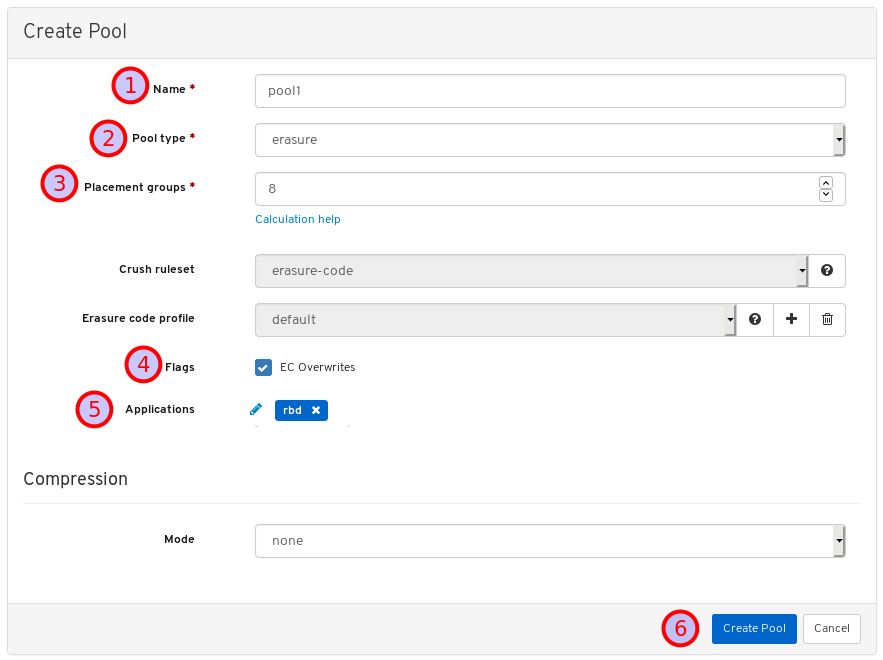

대화 상자 창에서 이름을 설정합니다.

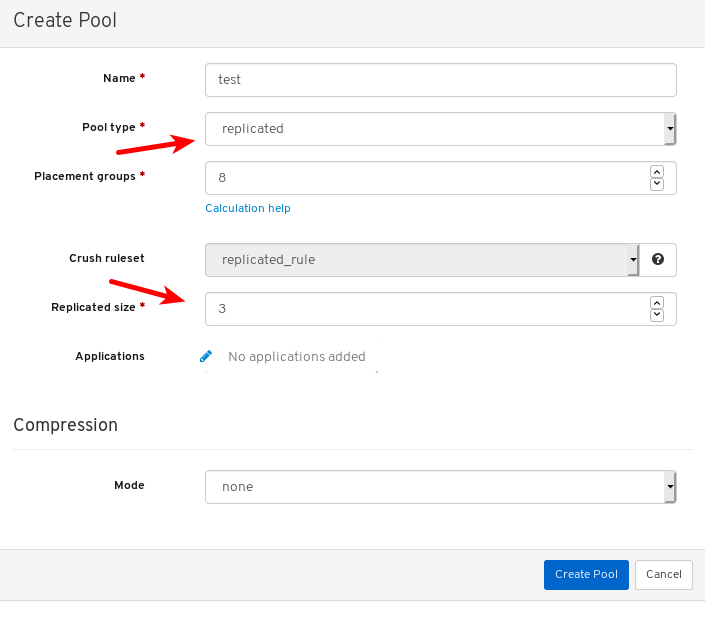

복제된 또는 Erasure Coded (EC) 풀 유형을 선택합니다.

PG(배치 그룹) 번호를 설정합니다.

PG 번호를 선택하는 데 도움이 필요하면 PG 계산기 를 사용하십시오. 확실하지 않은 경우 Red Hat 기술 지원에 문의하십시오.

선택 사항: 복제된 풀 유형을 사용하는 경우 복제된 크기를 설정합니다.

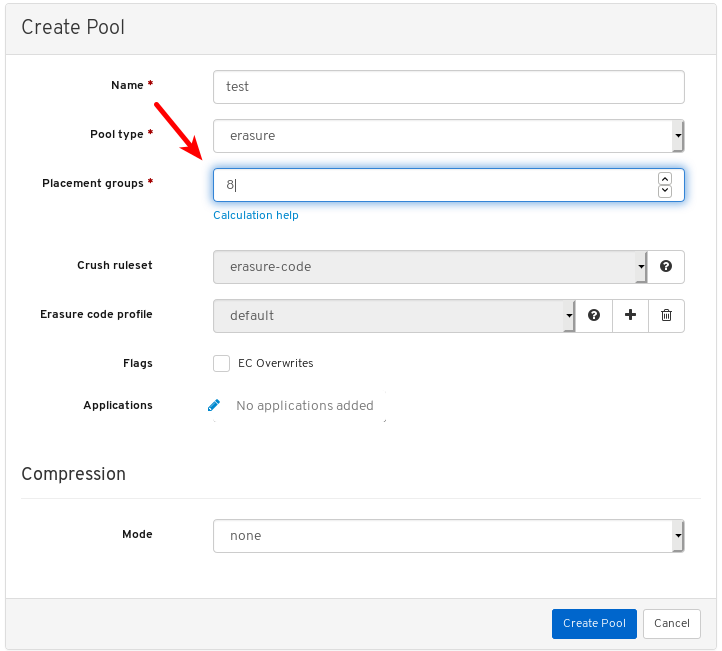

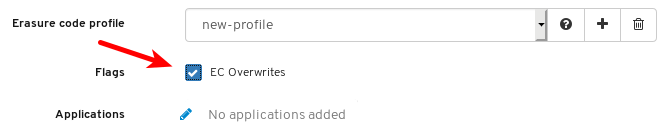

선택 사항: EC 풀 유형을 사용하는 경우 다음과 같은 추가 설정을 구성합니다.

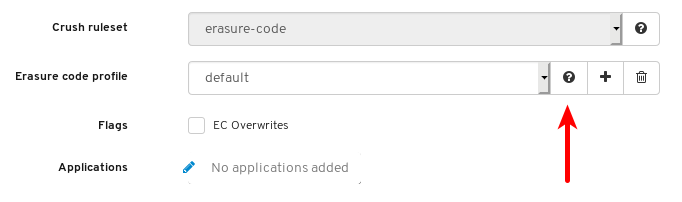

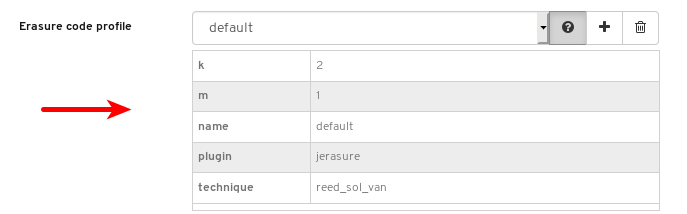

선택 사항: 현재 선택한 EC 프로필의 설정을 보려면 물음표를 클릭합니다.

선택한 EC 프로필의 설정 목록이 표시됩니다.

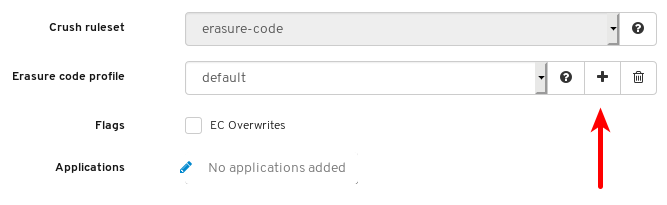

선택 사항: 더하기 기호를 클릭하여 새 EC 프로필을 추가합니다.

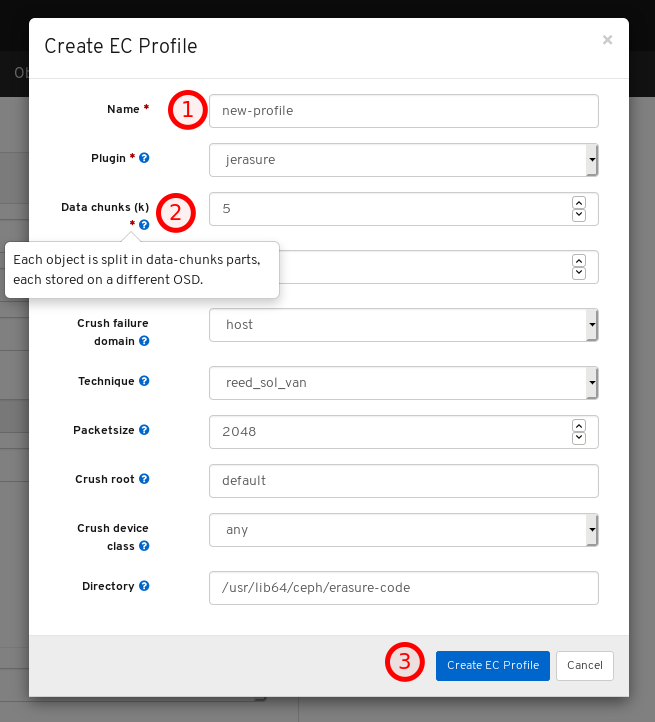

새 EC 프로필의 이름을 1 에서 2 로 클릭하고 필요한 모든 설정을 수정한 후 3 에서 해당 설정에 대한 정보에 대한 물음표 기호를 클릭합니다.

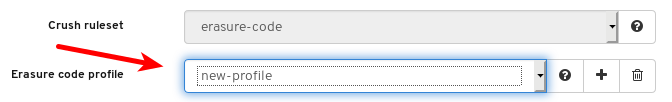

새 EC 프로필을 선택합니다.

선택 사항: EC 덮어쓰기가 필요한 경우 해당 버튼을 클릭합니다.

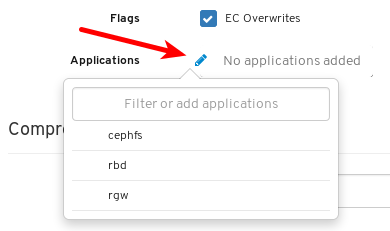

선택 사항: 연필 기호를 클릭하여 풀의 애플리케이션을 선택합니다.

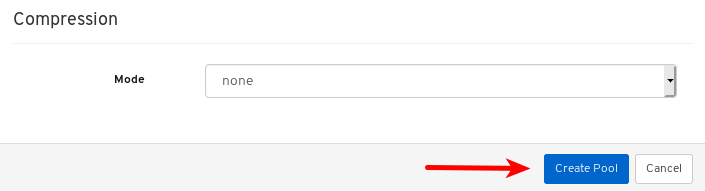

선택 사항: 압축이 필요한 경우 패시브,공격적 또는 강제로 선택합니다.

Create Pool (풀 생성) 버튼을 클릭합니다.

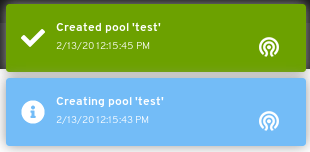

페이지 오른쪽 상단 모서리에 대한 알림은 풀이 성공적으로 생성되었음을 나타냅니다.

추가 리소스

- 자세한 내용은 아키텍처 가이드의 Ceph 풀 을 참조하십시오.

7.10.2. 풀 편집

Red Hat Ceph Storage 대시보드를 사용하면 풀을 편집할 수 있습니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 대시보드가 설치되어 있습니다.

- 풀이 생성됩니다.

절차

- 대시보드에 로그인합니다.

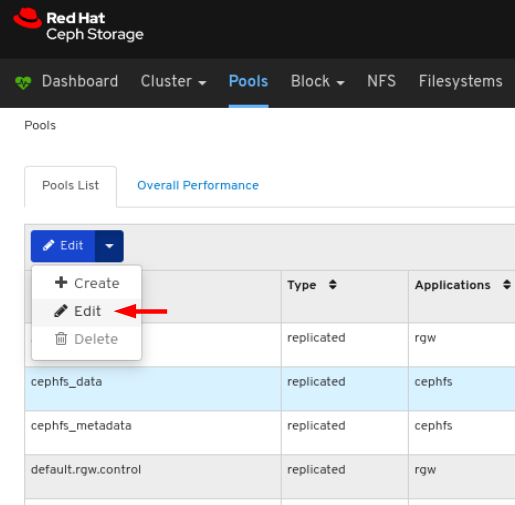

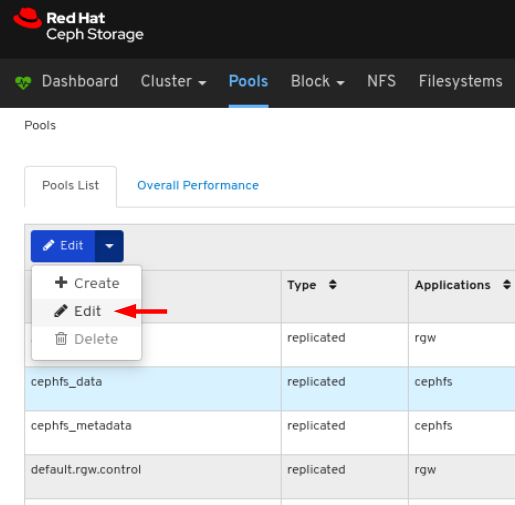

탐색 모음에서 풀 을 클릭합니다.

풀을 편집하려면 해당 행을 클릭합니다.

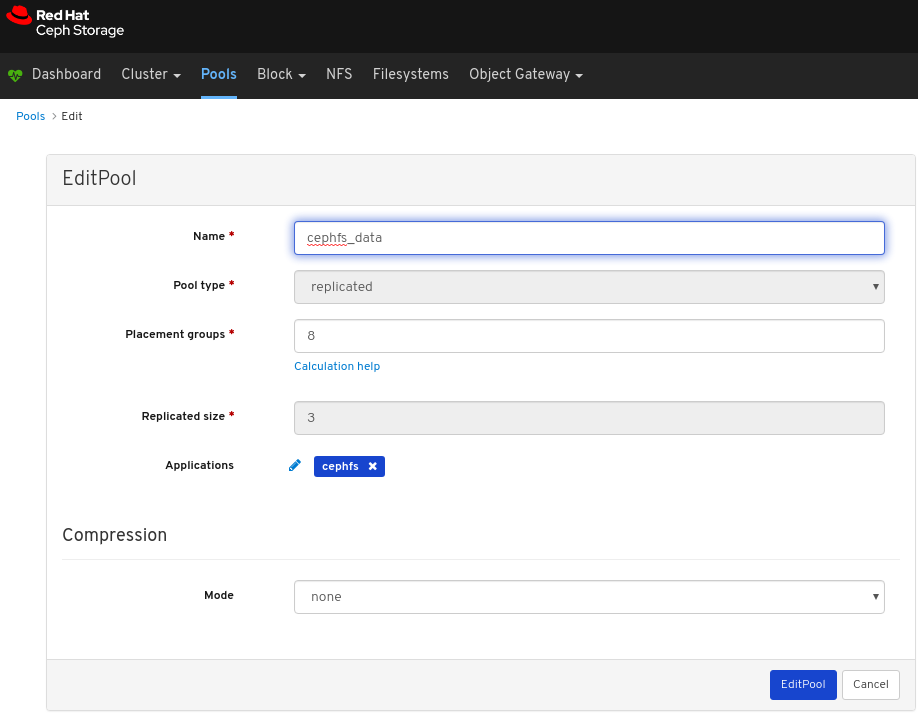

편집 드롭다운에서 편집 을 선택합니다.

대화 상자 창에서 필요한 매개 변수를 편집하고 EditPool 버튼을 클릭합니다.

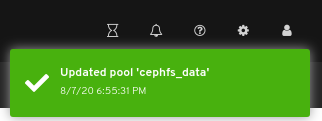

페이지 오른쪽 상단 모서리에 대한 알림은 풀이 성공적으로 업데이트되었음을 나타냅니다.

추가 리소스

- 자세한 내용은 Red Hat Ceph Storage Architecture Guide의 Ceph 풀 을 참조하십시오.

- 압축 모드에 대한 자세한 내용은 Red Hat Ceph Storage Strategies 가이드 의 Pool 값을 참조하십시오.

7.10.3. 풀 삭제

Red Hat Ceph Storage 대시보드를 사용하면 풀을 삭제할 수 있습니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 대시보드가 설치되어 있습니다.

- 풀이 생성됩니다.

절차

- 대시보드에 로그인합니다.

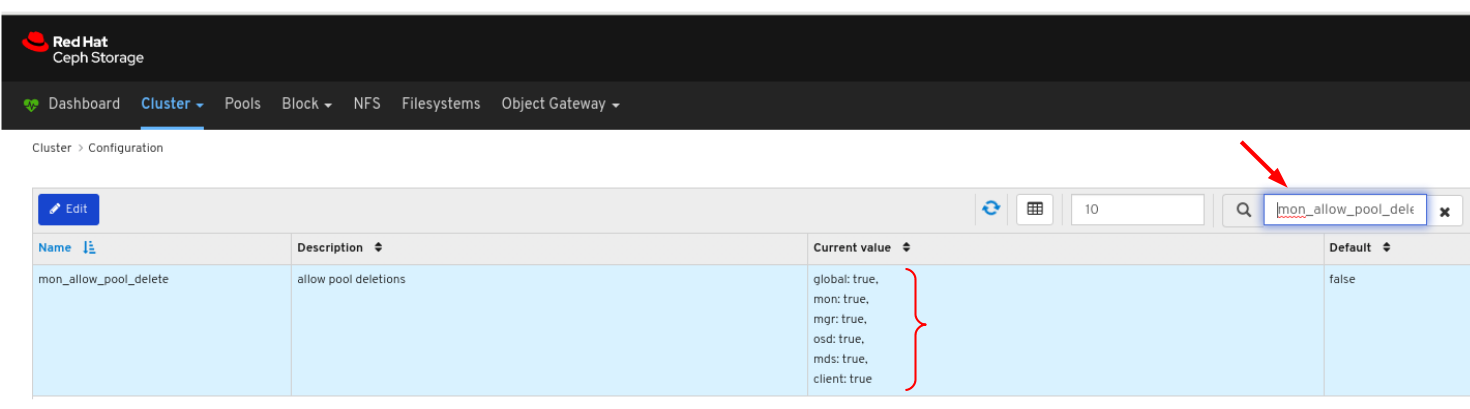

mon_allow_pool_delete값이true로 설정되어 있는지 확인합니다.- 탐색 모음에서 클러스터를 클릭한 다음 구성을 클릭합니다.On the navigation bar, click Cluster and then click Configuration.

수준 드롭다운 메뉴에서 고급 을 선택합니다.

mon_allow_pool_delete를 검색하고 값을true로 설정합니다.

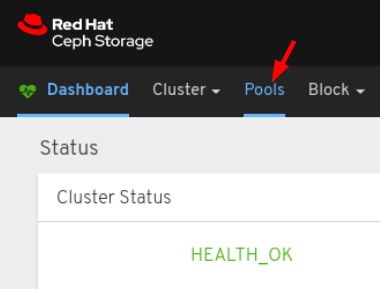

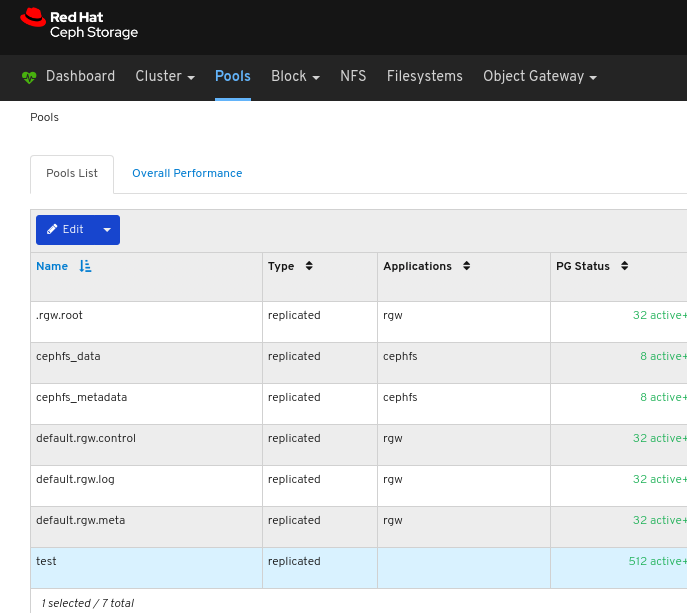

탐색 모음에서 풀을 클릭합니다.On the navigation bar, click Pools:

풀을 삭제하려면 해당 행을 클릭합니다.

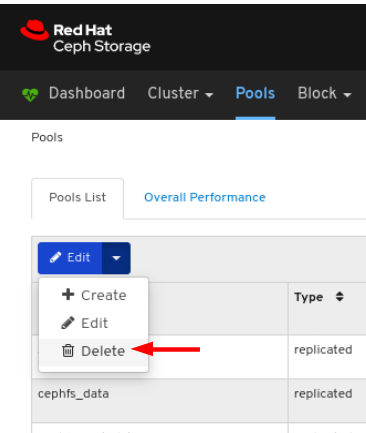

편집 드롭다운에서 삭제를 선택합니다.

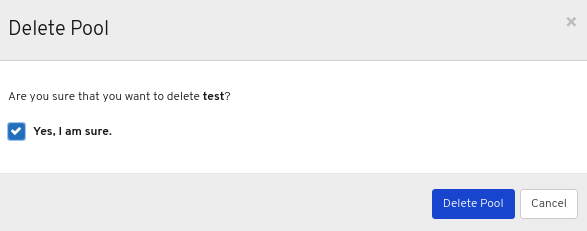

풀 삭제 대화 상자 창에서 Yes, I am sure 상자를 클릭한 다음 풀 삭제를 클릭하여 설정을 저장합니다.

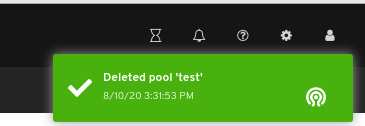

페이지 오른쪽 상단 모서리에 대한 알림은 풀이 성공적으로 삭제되었음을 나타냅니다.

추가 리소스

- 자세한 내용은 Red Hat Ceph Storage Architecture Guide의 Ceph 풀 을 참조하십시오.

- 자세한 내용은 Red Hat Ceph Storage Dashboard Guide 의 Monitoring Configuration 을 참조하십시오.

- 압축 모드에 대한 자세한 내용은 Red Hat Ceph Storage Strategies 가이드 의 Pool 값을 참조하십시오.

8장. 오브젝트 게이트웨이

스토리지 관리자로서 대시보드의 오브젝트 게이트웨이 기능을 사용하면 Ceph Object Gateway를 관리하고 모니터링할 수 있습니다.

예를 들어 모니터링 기능을 사용하면 영역 이름 또는 GET 및 PUT 비율의 성능 그래프와 같은 게이트웨이 데몬에 대한 세부 정보를 볼 수 있습니다. 관리 기능을 사용하면 사용자와 버킷을 모두 보고, 만들고, 편집할 수 있습니다.

오브젝트 게이트웨이 기능은 데몬 함수, 사용자 함수 및 버킷 함수로 나뉩니다.

8.1. 사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 대시보드가 설치되어 있습니다.

- Ceph Object Gateway가 설치되어 있습니다.

8.2. 오브젝트 게이트웨이 데몬 기능

스토리지 관리자는 Red Hat Ceph Storage 대시보드를 사용하여 Ceph Object Gateway 데몬에 대한 정보를 보고 모니터링할 수 있습니다.

8.2.1. 사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 대시보드가 설치되어 있습니다.

- Ceph Object Gateway가 설치되어 있습니다.

- 개체 게이트웨이 로그인 자격 증명이 대시보드에 추가됩니다.

8.2.2. 오브젝트 게이트웨이 데몬 보기

대시보드를 사용하면 모든 Ceph Object Gateway 데몬 목록을 볼 수 있습니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 대시보드가 설치되어 있습니다.

- Ceph Object Gateway가 설치되어 있습니다.

- 개체 게이트웨이 로그인 자격 증명이 대시보드에 추가됩니다.

절차

- 대시보드에 로그인합니다.

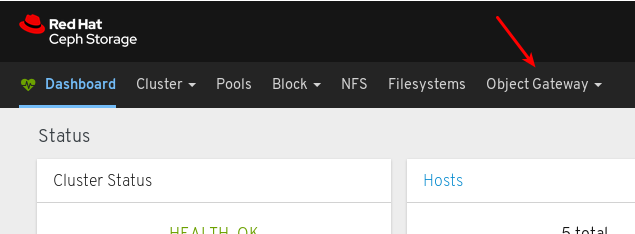

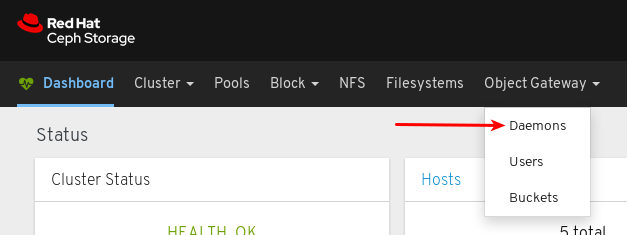

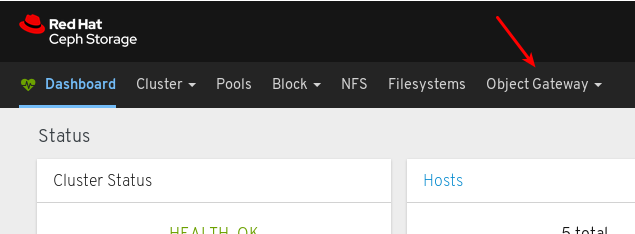

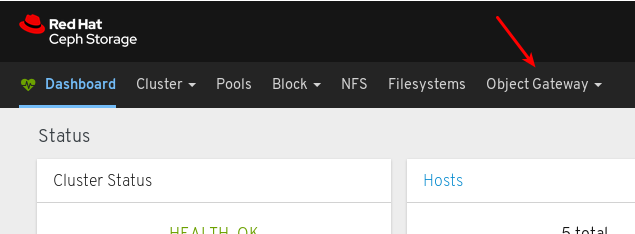

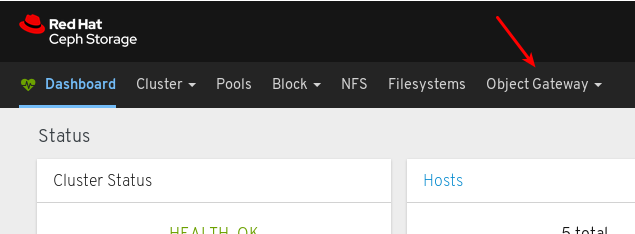

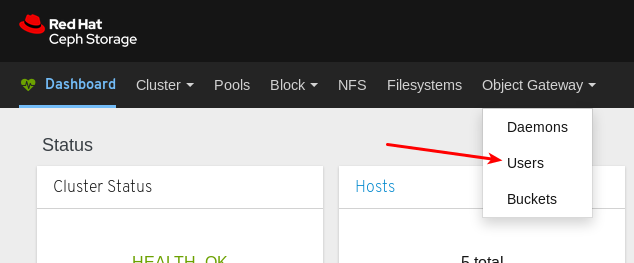

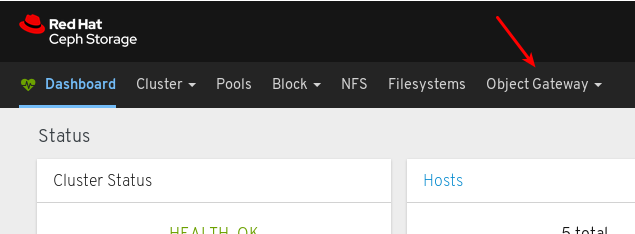

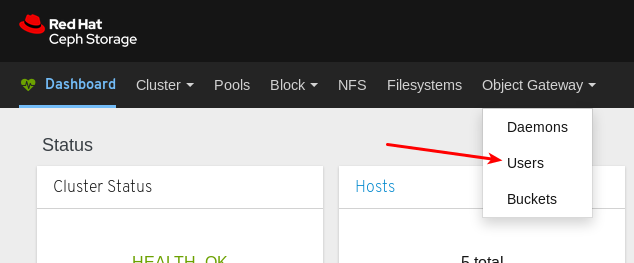

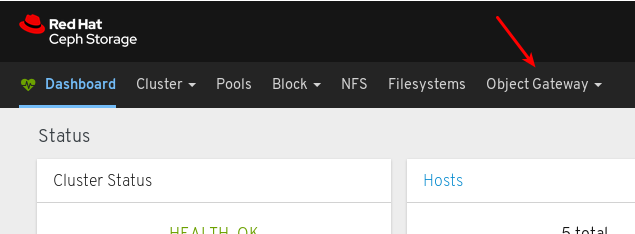

탐색 모음에서 오브젝트 게이트웨이를 클릭합니다.

데몬을 클릭합니다.

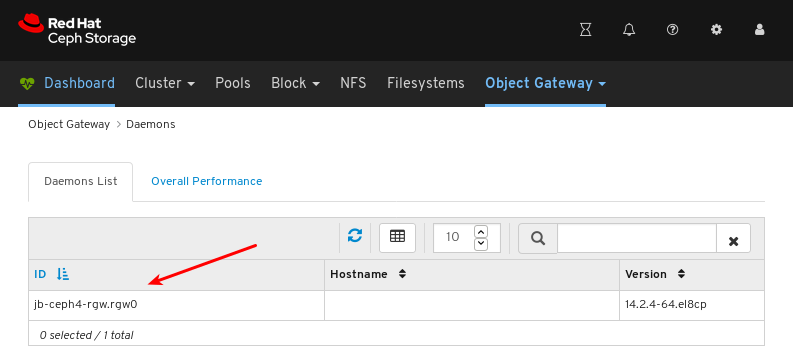

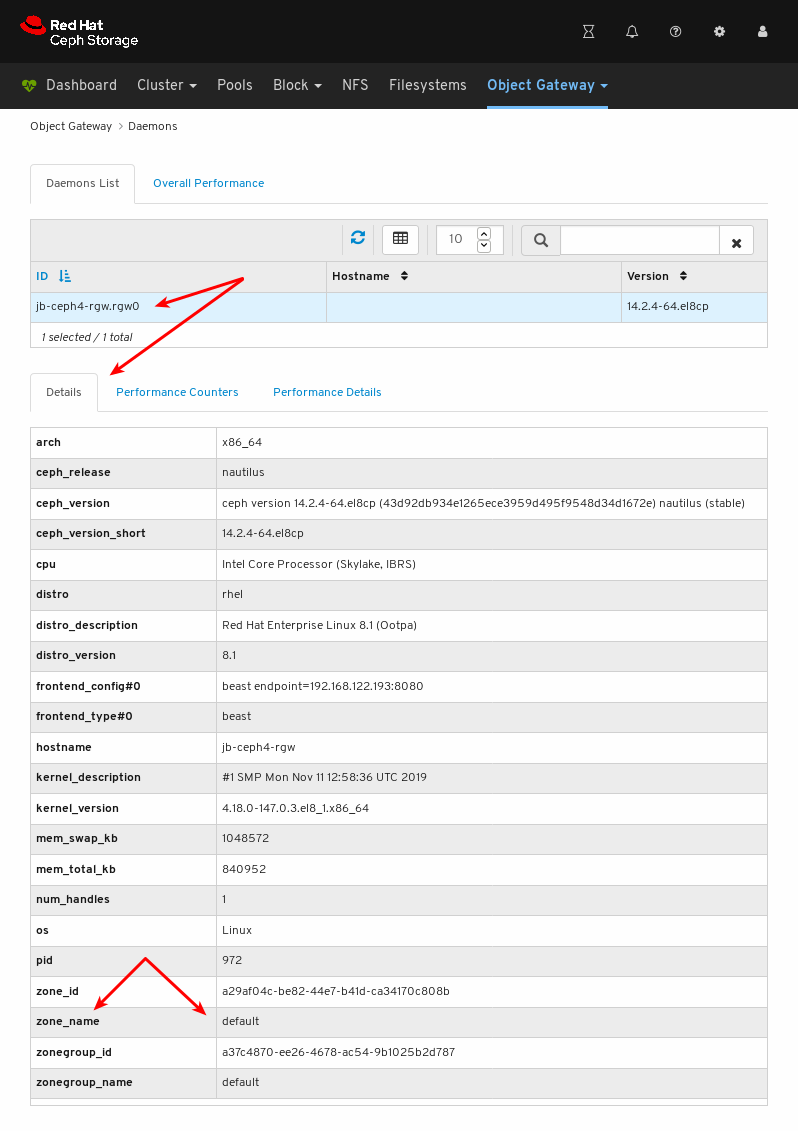

아래 예제에서는 Daemons List 에서 ID

jb-ceph4-rgw.rgw0이 있는 데몬을 확인할 수 있습니다.

세부 정보를 보려면

jb-ceph4-rgw.rgw0에 대한 행을 클릭하여 데몬을 선택합니다.

데몬이 제공하는 영역 이름이

기본임을 알 수 있습니다.

추가 리소스

- Ceph Object Gateway 설치 방법에 대한 자세한 내용은 설치 가이드의 Ceph 오브젝트 게이트웨이 설치를 참조하십시오.

- 대시보드에 오브젝트 게이트웨이 로그인 자격 증명을 추가하는 방법에 대한 자세한 내용은 대시보드 가이드의 대시보드에 오브젝트 게이트웨이 로그인 자격 증명 추가 를 참조하십시오.

8.3. 오브젝트 게이트웨이 사용자 기능

스토리지 관리자는 Red Hat Ceph Storage 대시보드를 사용하여 Ceph Object Gateway 사용자를 보고 관리할 수 있습니다.

8.3.1. 사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 대시보드가 설치되어 있습니다.

- Ceph Object Gateway가 설치되어 있습니다.

- 개체 게이트웨이 로그인 자격 증명이 대시보드에 추가됩니다.

8.3.2. 오브젝트 게이트웨이 사용자 보기

대시보드를 사용하면 모든 Ceph Object Gateway 사용자 목록을 볼 수 있습니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 대시보드가 설치되어 있습니다.

- Ceph Object Gateway가 설치되어 있습니다.

- 개체 게이트웨이 로그인 자격 증명이 대시보드에 추가됩니다.

절차

- 대시보드에 로그인합니다.

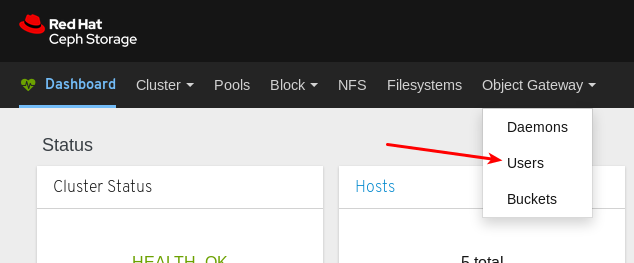

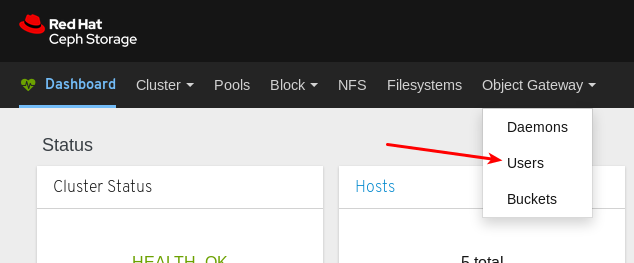

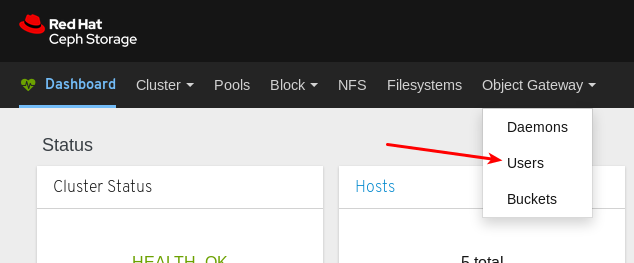

탐색 모음에서 오브젝트 게이트웨이를 클릭합니다.

사용자를 클릭합니다.

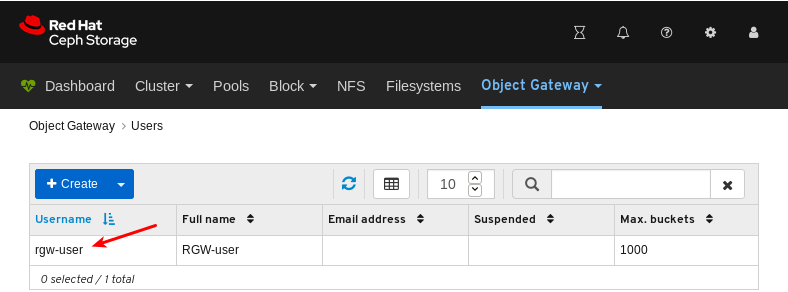

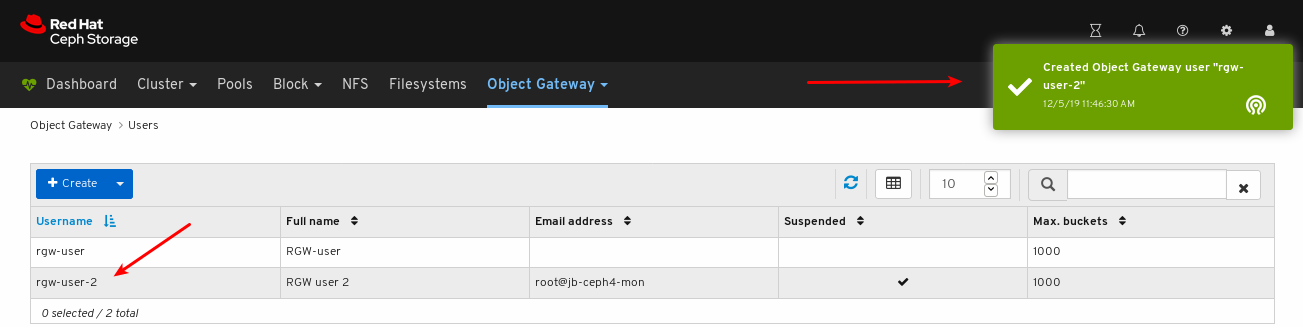

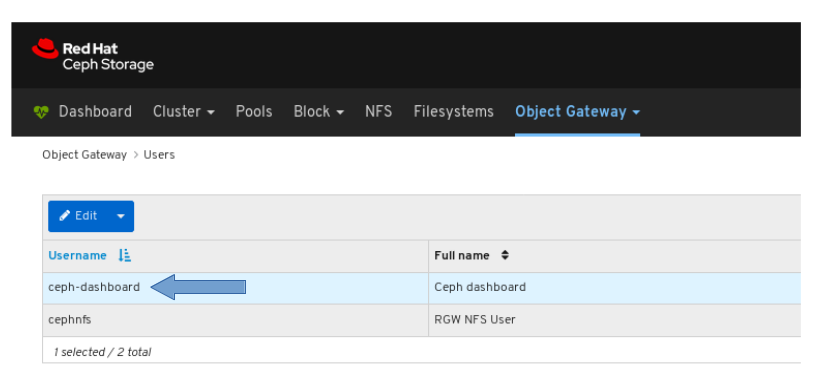

아래 예제에서는 테이블에

rgw-user라는 사용자를 볼 수 있습니다.

자세한 내용을 보려면

rgw-user의 행을 클릭하여 사용자를 선택합니다.

추가 리소스

- Ceph Object Gateway 설치 방법에 대한 자세한 내용은 설치 가이드의 Ceph 오브젝트 게이트웨이 설치를 참조하십시오.

- 대시보드에 오브젝트 게이트웨이 로그인 자격 증명을 추가하는 방법에 대한 자세한 내용은 대시보드 가이드의 대시보드에 오브젝트 게이트웨이 로그인 자격 증명 추가 를 참조하십시오.

- Ceph 개체 게이트웨이에 대한 자세한 내용은 Object Gateway Configuration and Administration Guide 를 참조하십시오.

8.3.3. 오브젝트 게이트웨이 사용자 생성

대시보드를 사용하면 Ceph Object Gateway 사용자를 만들 수 있습니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 대시보드가 설치되어 있습니다.

- Ceph Object Gateway가 설치되어 있습니다.

- 개체 게이트웨이 로그인 자격 증명이 대시보드에 추가됩니다.

절차

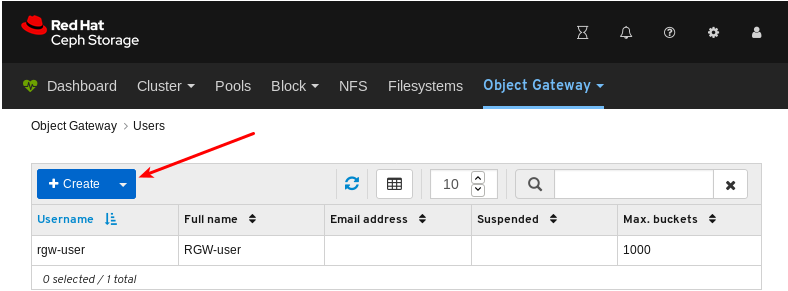

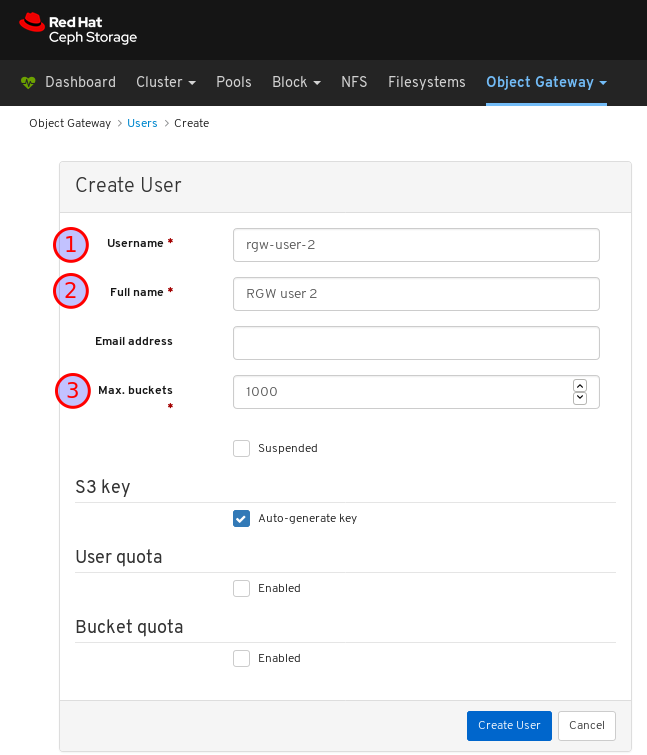

- 대시보드에 로그인합니다.

탐색 모음에서 오브젝트 게이트웨이를 클릭합니다.

사용자를 클릭합니다.

생성을 클릭합니다.

사용자 이름, 전체 이름을 설정하고 필요한 경우 최대 버킷 수를 편집합니다.

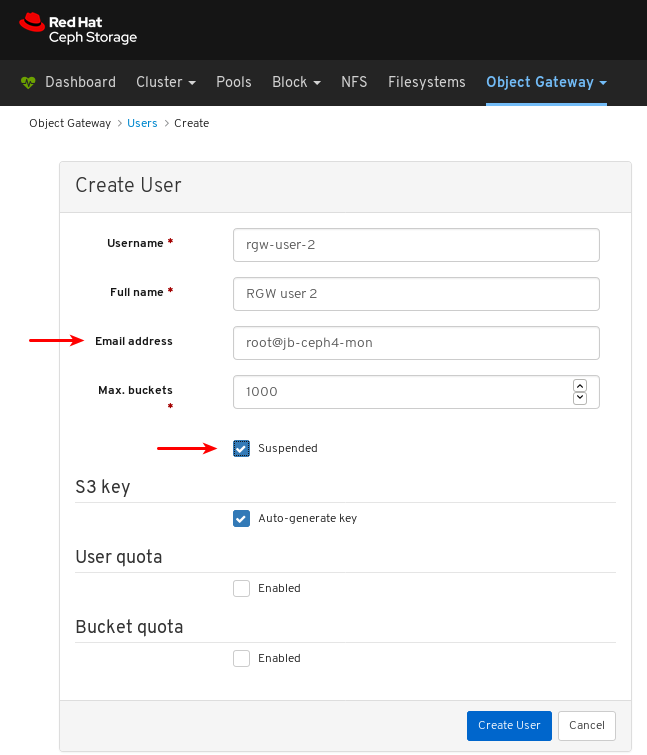

선택 사항: 이메일 주소 또는 일시 중단된 상태를 설정합니다.

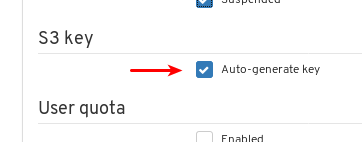

선택 사항: 자동 생성 키를 선택 해제하여 사용자 정의 액세스 키 및 시크릿 키를 설정합니다.

자동 생성 키를 선택 해제합니다.

액세스 키 및 시크릿 키를 설정합니다.

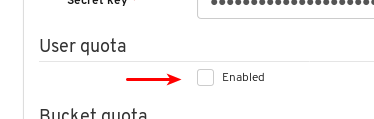

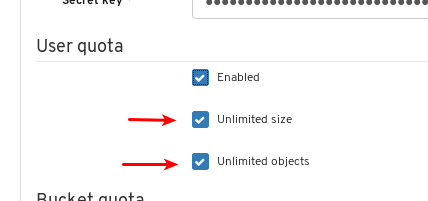

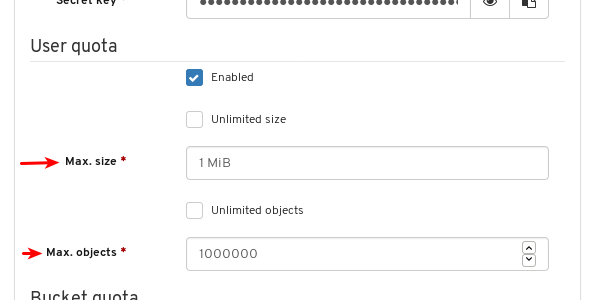

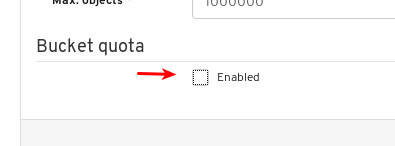

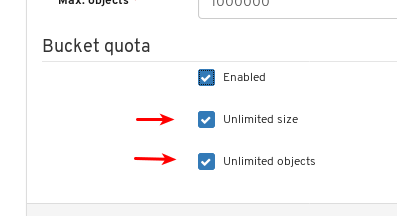

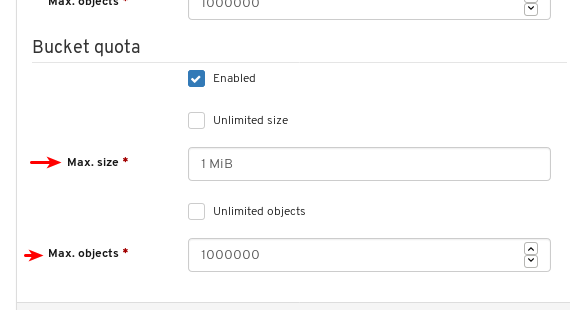

선택 사항: 사용자 할당량을 설정합니다.

사용자 할당량 에서 활성화 되었는지 확인합니다.

무제한 크기 또는 무제한 오브젝트를 선택 해제합니다.

Max. size 또는 Max. objects 에 필요한 값을 입력합니다.

선택 사항: 버킷 할당량을 설정합니다.

Bucket 할당량 에서 활성화 되었는지 확인합니다.

무제한 크기 또는 무제한 오브젝트를 선택 해제합니다.

Max. size 또는 Max. objects 에 필요한 값을 입력합니다.

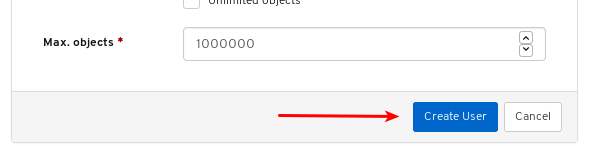

사용자 생성을 클릭하여 사용자 생성을 완료합니다.

사용자 생성에 성공했는지 확인합니다. 알림은 사용자가 생성되었음을 확인하고 사용자 테이블에 사용자를 볼 수 있습니다.

추가 리소스

- Ceph Object Gateway 설치 방법에 대한 자세한 내용은 설치 가이드의 Ceph 오브젝트 게이트웨이 설치를 참조하십시오.

- 대시보드에 오브젝트 게이트웨이 로그인 자격 증명을 추가하는 방법에 대한 자세한 내용은 대시보드 가이드의 대시보드에 오브젝트 게이트웨이 로그인 자격 증명 추가 를 참조하십시오.

- Ceph 개체 게이트웨이에 대한 자세한 내용은 Object Gateway Configuration and Administration Guide 를 참조하십시오.

8.3.4. 오브젝트 게이트웨이 사용자 편집

대시보드를 사용하면 Ceph Object Gateway 사용자를 편집할 수 있습니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 대시보드가 설치되어 있습니다.

- Ceph Object Gateway가 설치되어 있습니다.

- 개체 게이트웨이 로그인 자격 증명이 대시보드에 추가됩니다.

- Ceph Object Gateway 사용자가 생성되었습니다.

절차

- 대시보드에 로그인합니다.

탐색 모음에서 오브젝트 게이트웨이를 클릭합니다.

사용자를 클릭합니다.

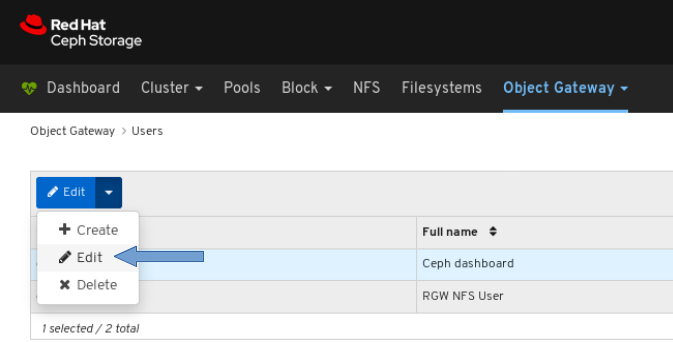

사용자 기능을 편집하려면 해당 행을 클릭합니다.

편집 드롭다운에서 편집 을 선택합니다.

EditUser 창에서 필요한 매개변수를 편집하고 EditUser 버튼을 클릭합니다.

페이지 오른쪽 상단 모서리에 대한 알림은 사용자가 성공적으로 업데이트되었음을 나타냅니다.

8.3.5. 오브젝트 게이트웨이 사용자 삭제

대시보드를 사용하면 Ceph Object Gateway 사용자를 삭제할 수 있습니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 대시보드가 설치되어 있습니다.

- Ceph Object Gateway가 설치되어 있습니다.

- 개체 게이트웨이 로그인 자격 증명이 대시보드에 추가됩니다.

- Ceph Object Gateway 사용자가 생성되었습니다.

절차

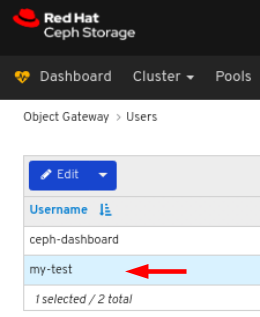

- 대시보드에 로그인합니다.

탐색 모음에서 오브젝트 게이트웨이를 클릭합니다.

사용자를 클릭합니다.

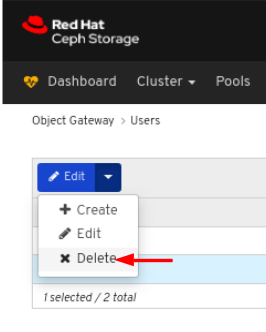

사용자를 삭제하려면 해당 행을 클릭합니다.

편집 드롭다운에서 삭제를 선택합니다.

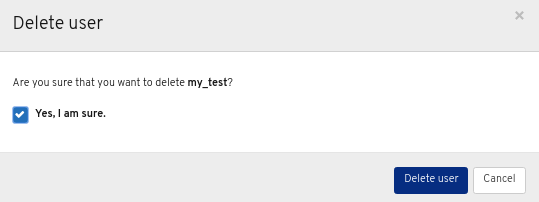

사용자 삭제 대화 상자에서 예, 예, 확인 대화 상자를 클릭한 다음 사용자 삭제를 클릭하여 설정을 저장합니다.In the Delete User dialog window, click the Yes, I am sure box and then click Delete User to save the settings:

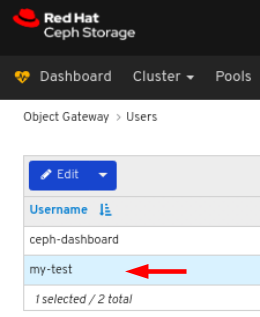

8.3.6. 오브젝트 게이트웨이 하위 사용자 생성

하위 사용자는 S3 인터페이스의 사용자와 연결되어 있습니다. 대시보드를 사용하면 Ceph Object Gateway 하위 사용자를 만들 수 있습니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 대시보드가 설치되어 있습니다.

- Ceph Object Gateway가 설치되어 있습니다.

- 개체 게이트웨이 로그인 자격 증명이 대시보드에 추가됩니다.

- 개체 게이트웨이 사용자가 생성됩니다.

절차

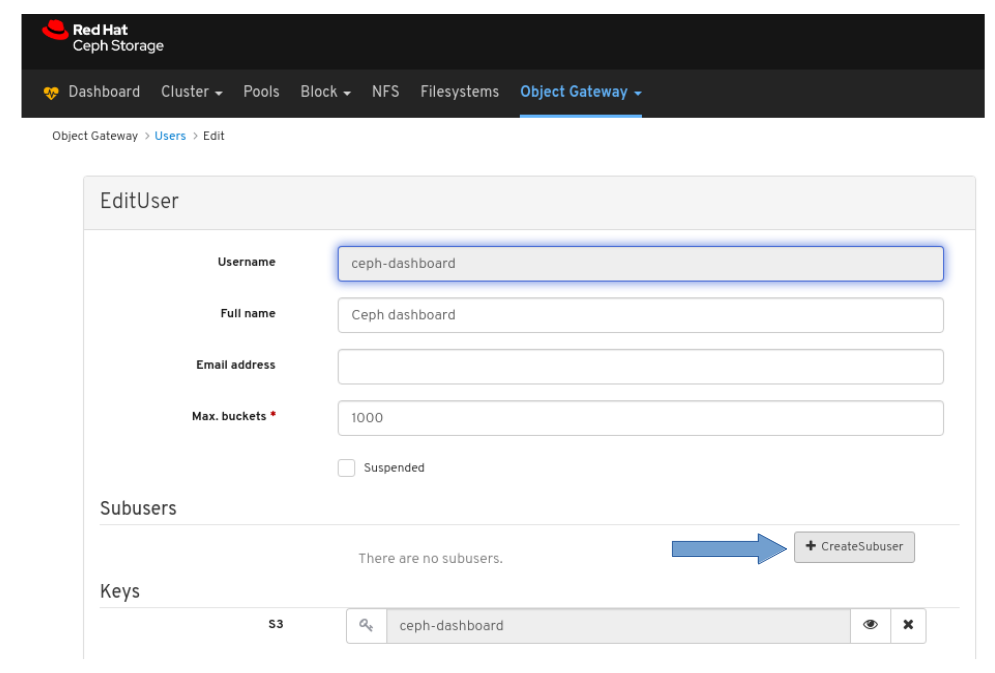

- 대시보드에 로그인합니다.

탐색 모음에서 오브젝트 게이트웨이를 클릭합니다.

드롭다운 메뉴에서 사용자를 클릭합니다.

아래 예제에서는 테이블에

ceph-dashboard라는 사용자를 확인할 수 있습니다. 행을 클릭하여 사용자를 선택합니다.

편집 드롭다운 메뉴를 클릭한 다음 편집 을 선택합니다.

+CreateSubuser 버튼을 클릭합니다.

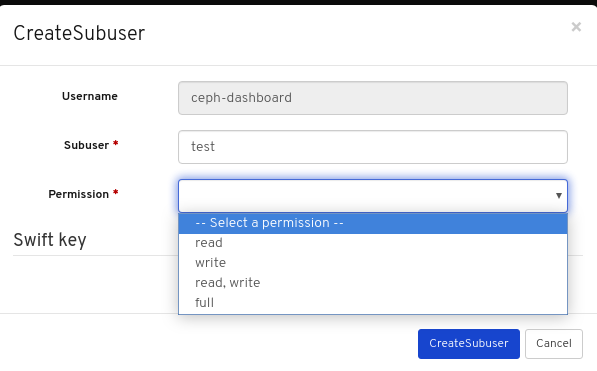

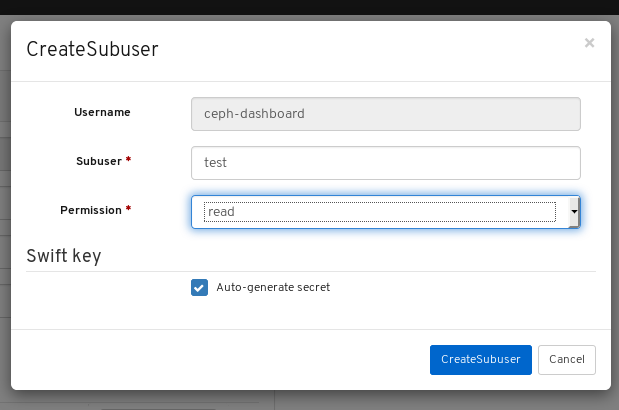

Subuser 이름을 입력하고 적절한 권한을 선택합니다.

Auto-generate secret 상자를 클릭한 다음 Create Subuser 버튼을 클릭합니다.

참고

참고Auto-generate-secret 확인란을 클릭하면 오브젝트 게이트웨이의 시크릿 키가 자동으로 생성됩니다.

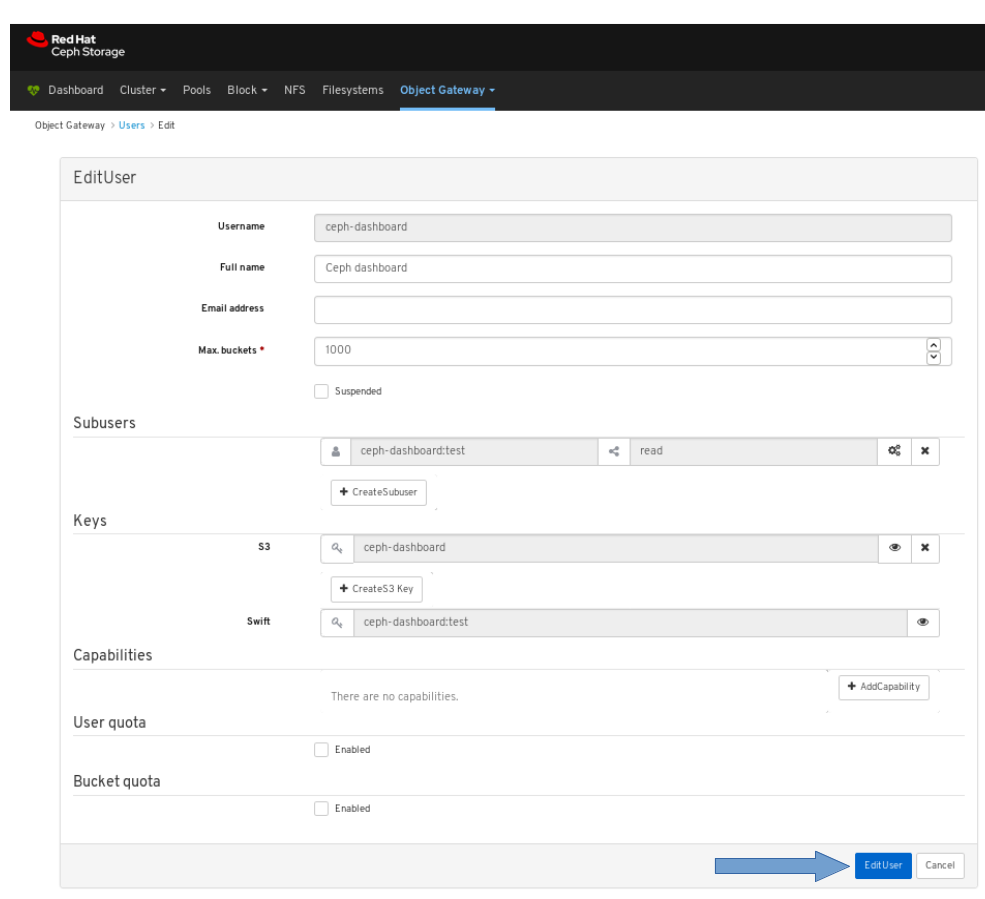

Edit User (사용자 편집) 창에서 Edit user (사용자 편집) 버튼을 클릭합니다.

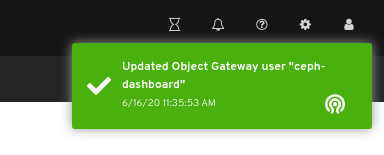

하위 사용자 생성에 성공했는지 확인합니다. 페이지의 오른쪽 상단 모서리에 대한 알림은 Object Gateway 사용자가 성공적으로 업데이트되었음을 나타냅니다.

추가 리소스

- Ceph Object Gateway 설치 방법에 대한 자세한 내용은 Red Hat Ceph Storage 설치 가이드에서 Ceph Object Gateway 설치를 참조하십시오.

- 대시보드에 개체 게이트웨이 로그인 자격 증명을 수동으로 추가하는 방법에 대한 자세한 내용은 대시보드 가이드의 대시보드에 개체 게이트웨이 로그인 자격 증명을 수동으로 추가하는 방법을 참조하십시오.

- Ceph 개체 게이트웨이에 대한 자세한 내용은 Object Gateway Configuration and Administration Guide 를 참조하십시오.

8.4. 오브젝트 게이트웨이 버킷 함수

스토리지 관리자는 Red Hat Ceph Storage 대시보드를 사용하여 Ceph Object Gateway 버킷을 보고 관리할 수 있습니다.

8.4.1. 사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 대시보드가 설치되어 있습니다.

- Ceph Object Gateway가 설치되어 있습니다.

- 개체 게이트웨이 로그인 자격 증명이 대시보드에 추가됩니다.

8.4.2. 오브젝트 게이트웨이 버킷 보기

대시보드를 사용하면 Ceph Object Gateway 버킷을 보고 관리할 수 있습니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 대시보드가 설치되어 있습니다.

- Ceph Object Gateway가 설치되어 있습니다.

- 개체 게이트웨이 로그인 자격 증명이 대시보드에 추가됩니다.

- 오브젝트 게이트웨이 버킷이 생성됩니다.

절차

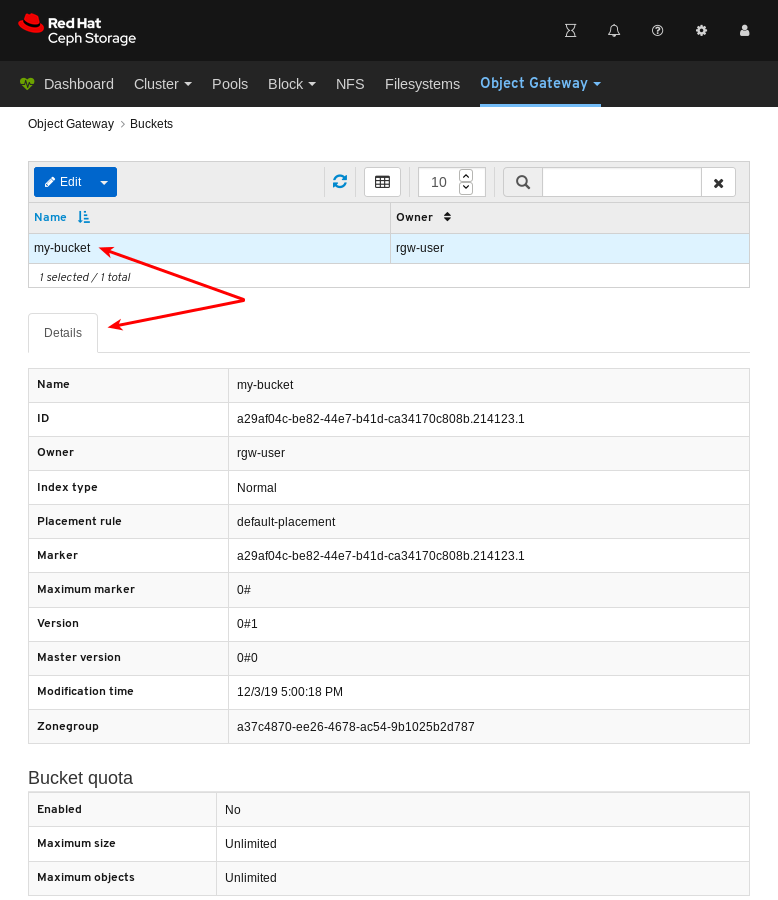

- 대시보드에 로그인합니다.

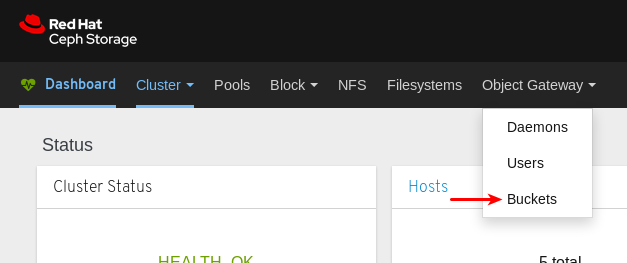

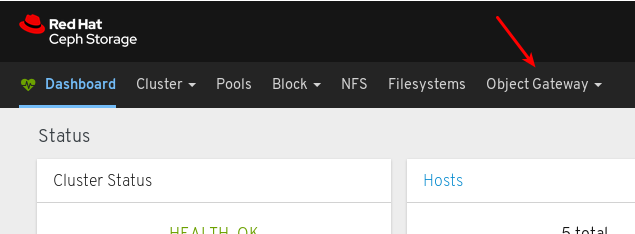

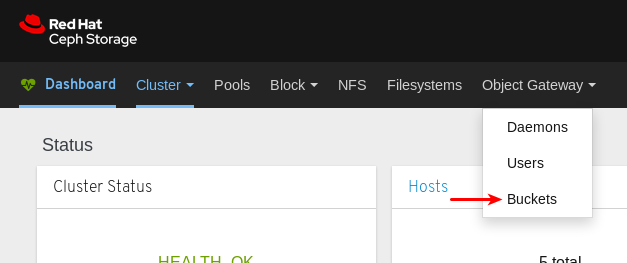

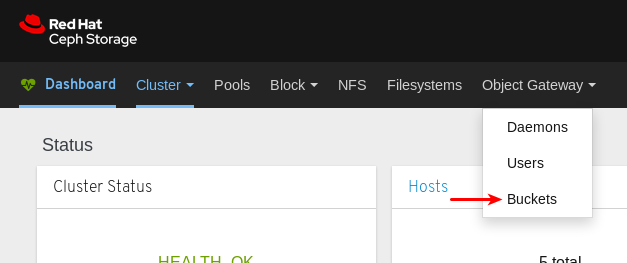

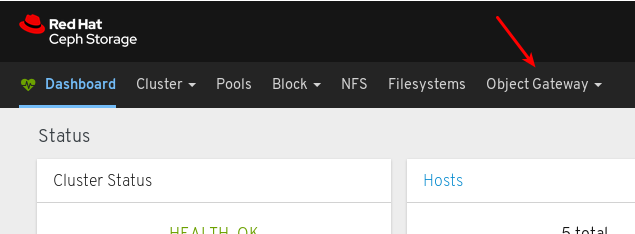

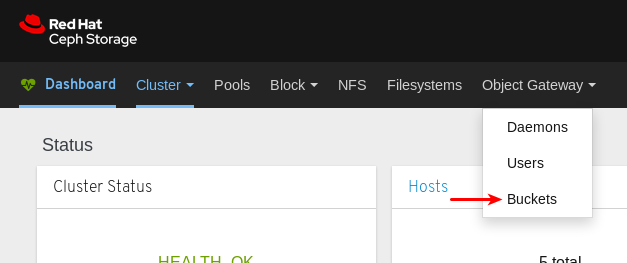

탐색 모음에서 오브젝트 게이트웨이를 클릭합니다.

Buckets 를 클릭합니다.

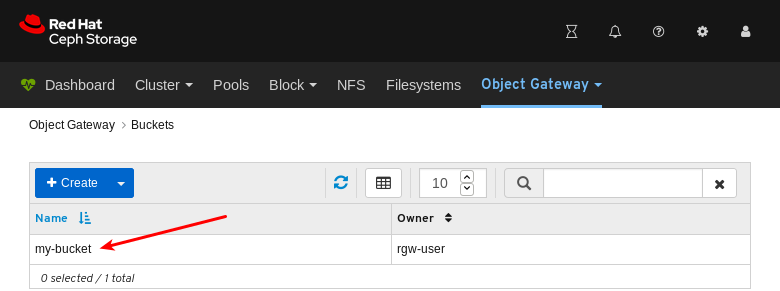

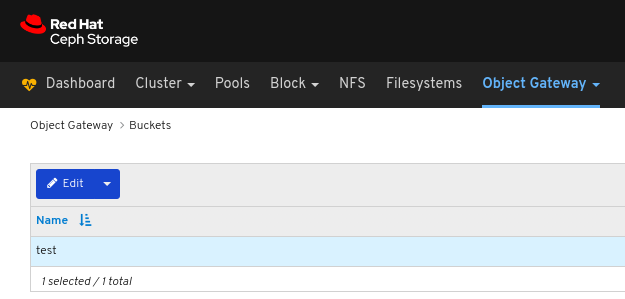

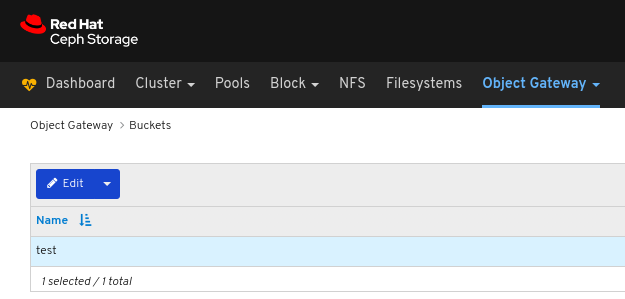

아래 예제에서는 표에

my-bucket이라는 버킷을 볼 수 있습니다.

세부 사항을 보려면

my-bucket행을 클릭하여 버킷을 선택합니다.

추가 리소스

- Ceph Object Gateway 설치 방법에 대한 자세한 내용은 설치 가이드의 Ceph 오브젝트 게이트웨이 설치를 참조하십시오.

- 대시보드에 오브젝트 게이트웨이 로그인 자격 증명을 추가하는 방법에 대한 자세한 내용은 대시보드 가이드의 대시보드에 오브젝트 게이트웨이 로그인 자격 증명 추가 를 참조하십시오.

- Ceph 개체 게이트웨이에 대한 자세한 내용은 Object Gateway Configuration and Administration Guide 를 참조하십시오.

8.4.3. 오브젝트 게이트웨이 버킷 생성

대시보드를 사용하면 Ceph Object Gateway 버킷을 만들 수 있습니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 대시보드가 설치되어 있습니다.

- Ceph Object Gateway가 설치되어 있습니다.

- 개체 게이트웨이 로그인 자격 증명이 대시보드에 추가됩니다.

- 일시 중지되지 않은 개체 게이트웨이 사용자가 생성됩니다.

절차

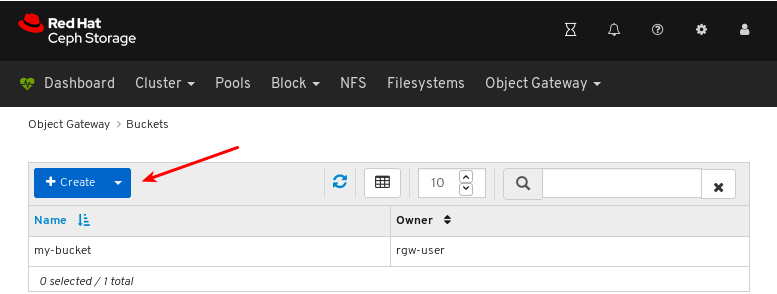

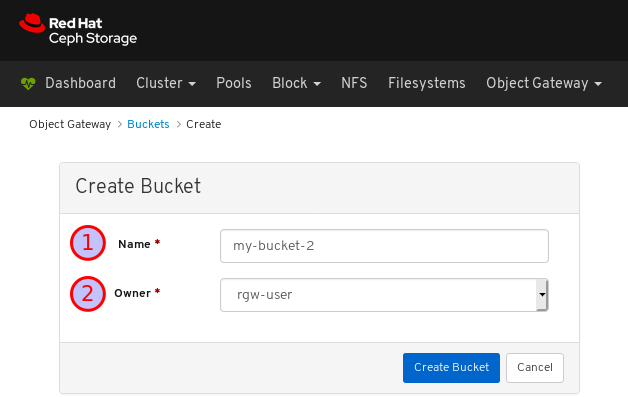

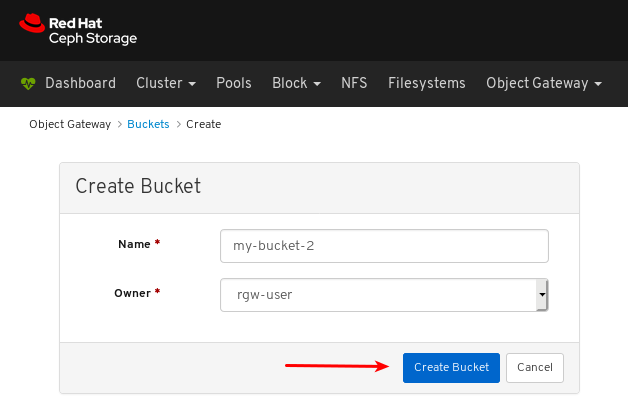

- 대시보드에 로그인합니다.

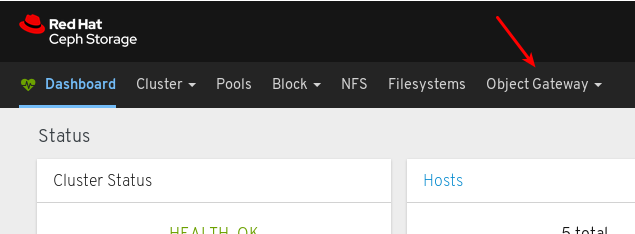

탐색 모음에서 오브젝트 게이트웨이를 클릭합니다.

Buckets 를 클릭합니다.

생성을 클릭합니다.

Name (이름)에 값을 입력하고 일시 중지되지 않은 사용자를 선택합니다.

버킷 생성을 클릭합니다.

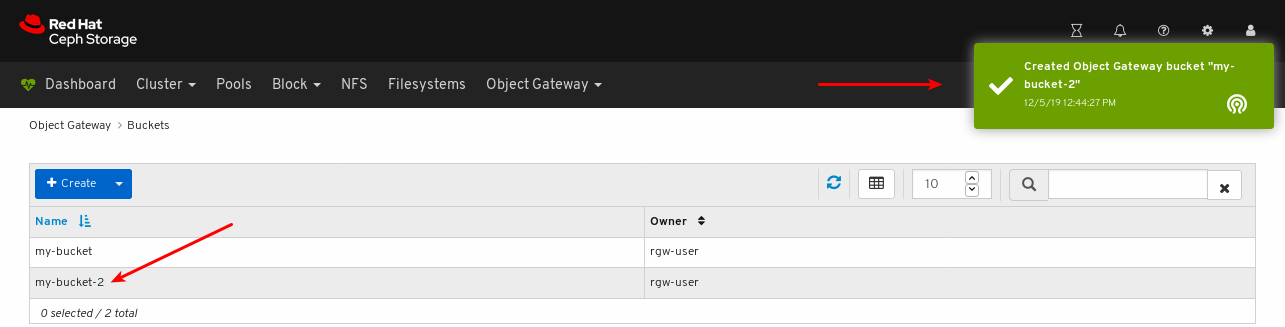

버킷 생성에 성공했는지 확인합니다. 알림은 버킷이 생성되고 버킷 테이블에 버킷을 볼 수 있는지 확인합니다.

추가 리소스

- Ceph Object Gateway 설치 방법에 대한 자세한 내용은 설치 가이드의 Ceph 오브젝트 게이트웨이 설치를 참조하십시오.

- 대시보드에 오브젝트 게이트웨이 로그인 자격 증명을 추가하는 방법에 대한 자세한 내용은 대시보드 가이드의 대시보드에 오브젝트 게이트웨이 로그인 자격 증명 추가 를 참조하십시오.

- Ceph 개체 게이트웨이에 대한 자세한 내용은 Object Gateway Configuration and Administration Guide 를 참조하십시오.

8.4.4. 오브젝트 게이트웨이 버킷 편집

대시보드를 사용하면 Ceph Object Gateway 버킷을 편집할 수 있습니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 대시보드가 설치되어 있습니다.

- Ceph Object Gateway가 설치되어 있습니다.

- 개체 게이트웨이 로그인 자격 증명이 대시보드에 추가됩니다.

- 일시 중지되지 않은 Ceph Object Gateway 사용자가 생성됩니다.

- Ceph Object Gateway 버킷이 생성되었습니다.

절차

- 대시보드에 로그인합니다.

탐색 모음에서 오브젝트 게이트웨이를 클릭합니다.

Buckets 를 클릭합니다.

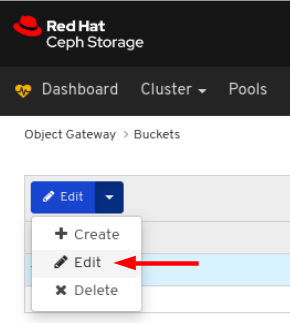

버킷을 편집하려면 해당 행을 클릭합니다.

편집 드롭다운에서 편집 을 선택합니다.

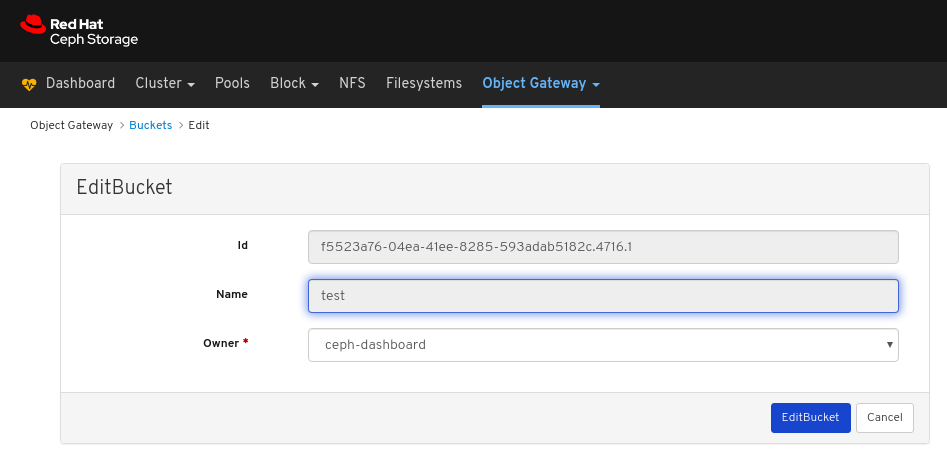

EditBucket 창에서 필요한 매개변수를 편집하고 EditBucket 버튼을 클릭합니다.

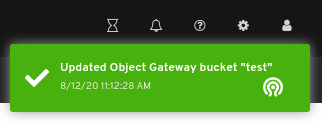

페이지 오른쪽 상단 모서리에 대한 알림은 버킷이 성공적으로 업데이트되었음을 나타냅니다.

추가 리소스

- 자세한 내용은 Red Hat Ceph Storage 설치 가이드의 CephObject Gateway 섹션을 참조하십시오.

- 자세한 내용은 Red Hat Ceph Storage Dashboard Guide 의 Add object gateway login credentials 섹션을 참조하십시오.

8.4.5. 오브젝트 게이트웨이 버킷 삭제

대시보드를 사용하면 Ceph Object Gateway 버킷을 삭제할 수 있습니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 대시보드가 설치되어 있습니다.

- Ceph Object Gateway가 설치되어 있습니다.

- 개체 게이트웨이 로그인 자격 증명이 대시보드에 추가됩니다.

- 일시 중지되지 않은 Ceph Object Gateway 사용자가 생성됩니다.

- Ceph Object Gateway 버킷이 생성되었습니다.

절차

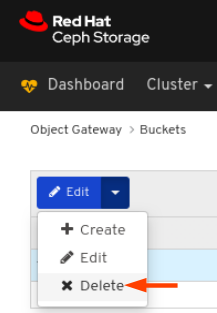

- 대시보드에 로그인합니다.

탐색 모음에서 오브젝트 게이트웨이를 클릭합니다.

Buckets 를 클릭합니다.

버킷을 삭제하려면 해당 행을 클릭합니다.

편집 드롭다운에서 삭제를 선택합니다.

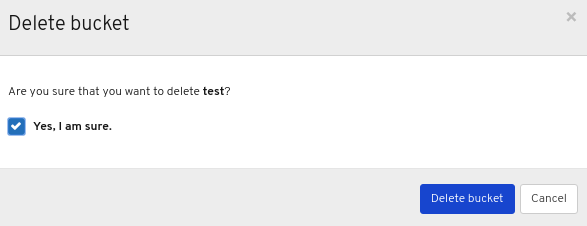

삭제 대화 상자 창에서 예, 예, 버킷 삭제를 클릭하여 설정을 저장합니다.

8.5. 대시보드에 개체 게이트웨이 로그인 인증 정보 추가

Red Hat Ceph Storage 대시보드는 RADOS 게이트웨이 또는 RGW라고도 하는 Ceph Object Gateway를 관리할 수 있습니다. Ceph Object Gateway를 관리하려면 대시보드는 시스템 플래그와 함께 RGW 사용자의 로그인 자격 증명을 사용하여 연결해야 합니다. ceph-ansible 을 사용하여 오브젝트 게이트웨이를 설치하면 대시보드에 로그인 인증 정보가 자동으로 추가됩니다. 로그인 인증 정보를 수동으로 설정할 수도 있습니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 대시보드가 설치되어 있습니다.

- Ceph Object Gateway가 설치되어 있습니다.

절차

시스템플래그가 활성화된 RGW 사용자의access_key및secret_key를 가져옵니다.시스템플래그가 활성화된 RGW 사용자가 없는 경우 새로 생성합니다.radosgw-admin user create --uid=USER_ID --display-name=DISPLAY_NAME --system

예제:

[root@mon ~]# radosgw-admin user create --uid=rgw-user --display-name=RGW-user --system { "user_id": "rgw-user", "display_name": "RGW-user", "email": "", "suspended": 0, "max_buckets": 1000, "subusers": [], "keys": [ { "user": "rgw-user", "access_key": "BYC5SWQQH24A2BFHS2RC", "secret_key": "159d94uHK9ADiWZrGsNYWYjRXCDrhL2xVi8PO6kT" } ], "swift_keys": [], "caps": [], "op_mask": "read, write, delete", "system": "true", "default_placement": "", "default_storage_class": "", "placement_tags": [], "bucket_quota": { "enabled": false, "check_on_raw": false, "max_size": -1, "max_size_kb": 0, "max_objects": -1 }, "user_quota": { "enabled": false, "check_on_raw": false, "max_size": -1, "max_size_kb": 0, "max_objects": -1 }, "temp_url_keys": [], "type": "rgw", "mfa_ids": [] }access_key및secret_key의 값을 기록해 둡니다. 위의 예에서access_key는BYC5SWQH24A2BFHS2RC이고secret_key는159d94uHK9ADiWZrGsNYWYRXCDrhL2xVi8PO6kT입니다.시스템플래그가 활성화된 RGW 사용자가 이미 생성된 경우radosgw-admin유틸리티의user info명령을 사용하여 자격 증명을 가져옵니다.radosgw-admin user info --uid=USER_ID예제:

[root@mon ~]# radosgw-admin user info --uid=rgw-user { "user_id": "rgw-user", "display_name": "RGW-user", "email": "", "suspended": 0, "max_buckets": 1000, "subusers": [], "keys": [ { "user": "rgw-user", "access_key": "BYC5SWQQH24A2BFHS2RC", "secret_key": "159d94uHK9ADiWZrGsNYWYjRXCDrhL2xVi8PO6kT" } ], "swift_keys": [], "caps": [], "op_mask": "read, write, delete", "system": "true", "default_placement": "", "default_storage_class": "", "placement_tags": [], "bucket_quota": { "enabled": false, "check_on_raw": false, "max_size": -1, "max_size_kb": 0, "max_objects": -1 }, "user_quota": { "enabled": false, "check_on_raw": false, "max_size": -1, "max_size_kb": 0, "max_objects": -1 }, "temp_url_keys": [], "type": "rgw", "mfa_ids": [] }access_key및secret_key의 값을 기록해 둡니다. 위의 예에서access_key는BYC5SWQH24A2BFHS2RC이고secret_key는159d94uHK9ADiWZrGsNYWYRXCDrhL2xVi8PO6kT입니다.

대시보드에

access_key및secret_key인증 정보를 제공합니다.대시보드에

access_key를 제공합니다.ceph dashboard set-rgw-api-access-key ACCESS_KEY예제:

[root@mon ~]# ceph dashboard set-rgw-api-access-key BYC5SWQQH24A2BFHS2RC Option RGW_API_ACCESS_KEY updated

대시보드에

secret_key를 제공합니다.ceph dashboard set-rgw-api-secret-key SECRET_KEY예제:

[root@mon ~]# ceph dashboard set-rgw-api-secret-key 159d94uHK9ADiWZrGsNYWYjRXCDrhL2xVi8PO6kT Option RGW_API_SECRET_KEY updated

대시보드에 오브젝트 게이트웨이의 호스트 이름과 포트를 제공합니다.

대시보드에 호스트 이름을 제공합니다.

ceph dashboard set-rgw-api-host HOST_NAME예제:

[root@mon ~]# ceph dashboard set-rgw-api-host 192.168.122.193 Option RGW_API_HOST updated

대시보드에 포트를 제공합니다.

ceph dashboard set-rgw-api-port PORT예제:

[root@mon ~]# ceph dashboard set-rgw-api-port 8080 Option RGW_API_PORT updated

선택 사항: 자체 서명된 인증서와 함께 HTTPS를 사용하는 경우 연결이 거부되지 않도록 대시보드에서 인증서 확인을 비활성화합니다.

거부된 연결은 인증서가 알 수 없는 인증 기관에서 서명되거나 사용된 호스트 이름이 인증서의 호스트 이름과 일치하지 않는 경우 발생할 수 있습니다.

ceph dashboard set-rgw-api-ssl-verify false

예제:

[root@mon ~]# ceph dashboard set-rgw-api-ssl-verify false Option RGW_API_SSL_VERIFY updated

추가 리소스

- Ceph Object Gateway 설치 방법에 대한 자세한 내용은 설치 가이드의 Ceph 오브젝트 게이트웨이 설치를 참조하십시오.

- Ceph 개체 게이트웨이에 대한 자세한 내용은 Object Gateway Configuration and Administration Guide 를 참조하십시오.

9장. 블록 장치

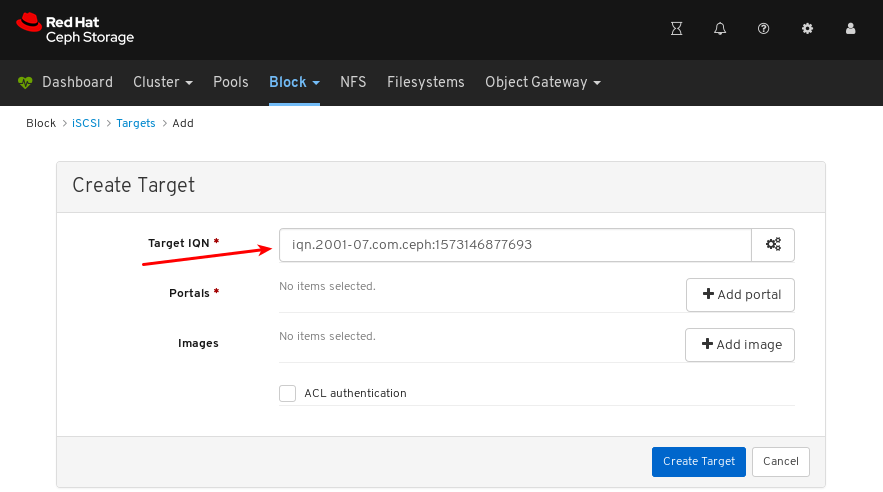

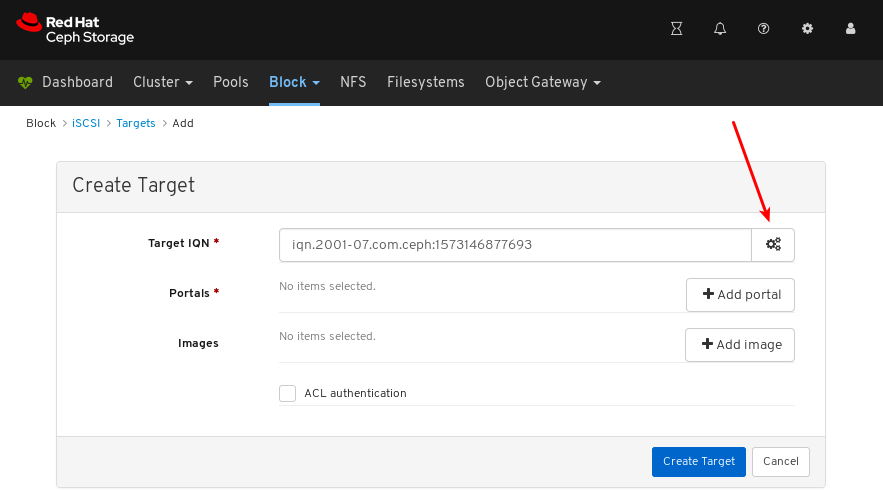

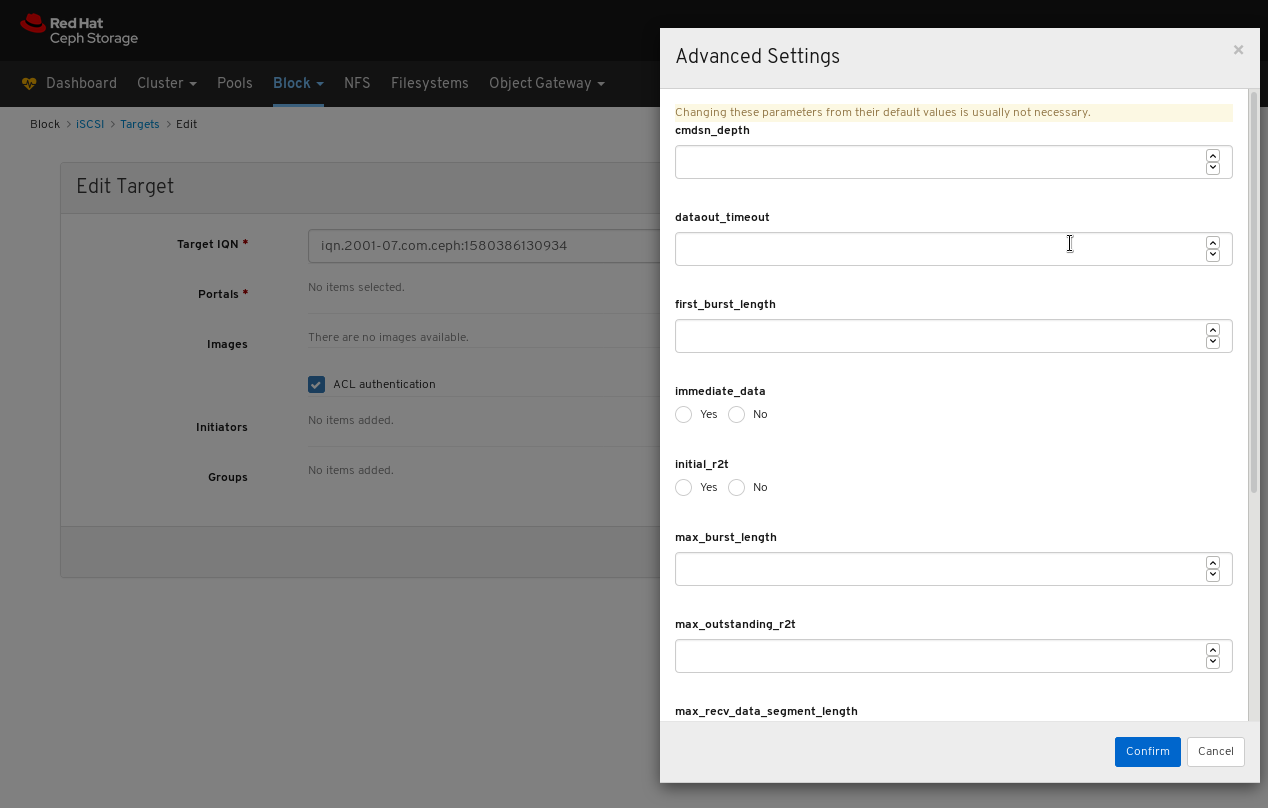

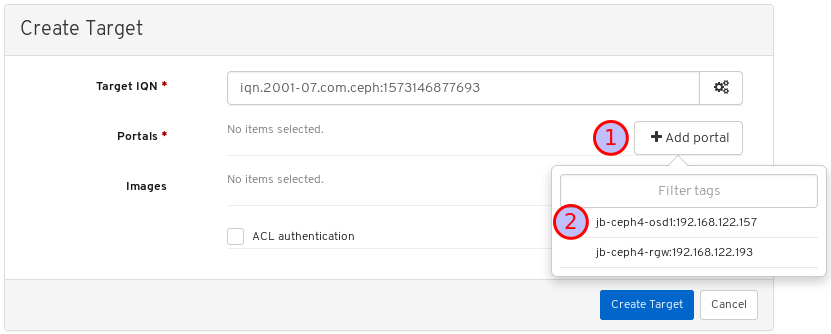

9.1. 블록 장치 소개

대시보드의 블록 장치 기능을 사용하면 블록 장치 이미지를 관리하고 모니터링할 수 있습니다. 이 기능은 일반적인 이미지 기능, 미러링 기능, iSCSI 기능 및 서비스 구성 품질로 나뉩니다. 예를 들어, 새 이미지를 생성하고, 클러스터에서 미러링된 이미지의 상태를 보고, iSCSI 대상을 관리 또는 모니터링하며, 이미지에 IOPS 제한을 설정할 수 있습니다.

9.2. 이미지 기능

대시보드는 이미지 관리 및 모니터링과 관련된 몇 가지 기능을 제공합니다.

9.2.1. 사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 대시보드가 설치되어 있습니다.

9.2.2. 이미지 생성

대시보드를 사용하면 이미지를 만들 수 있습니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 대시보드가 설치되어 있습니다.

- rbd 애플리케이션이 활성화된 풀이 생성됩니다.

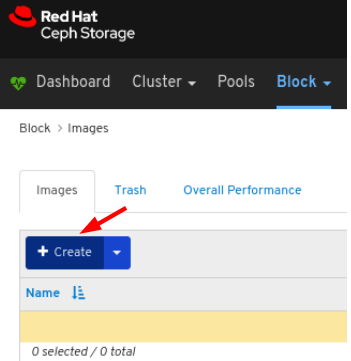

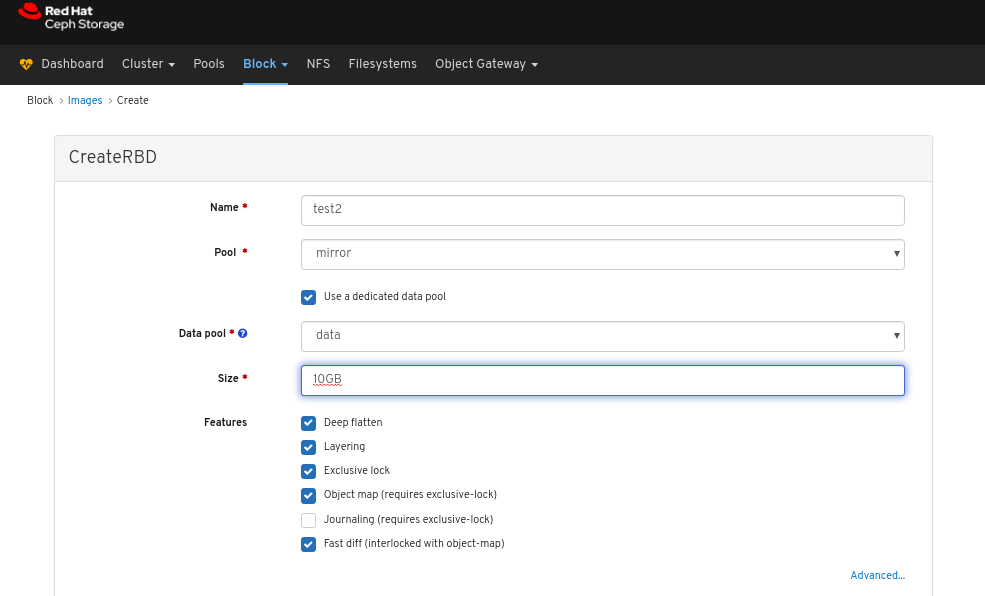

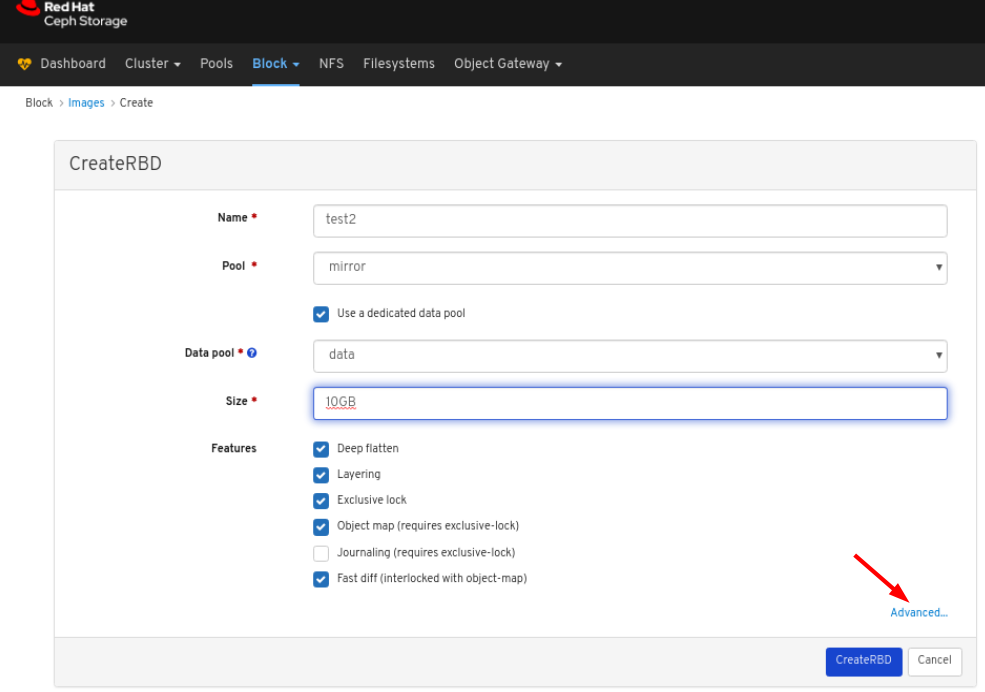

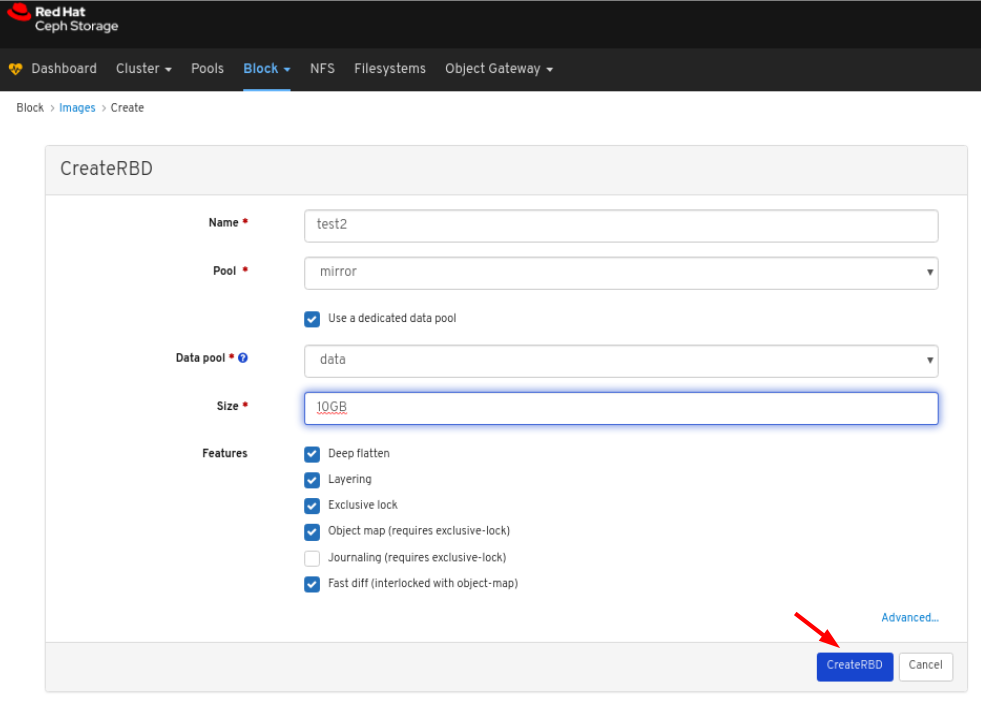

절차

- 대시보드에 로그인합니다.

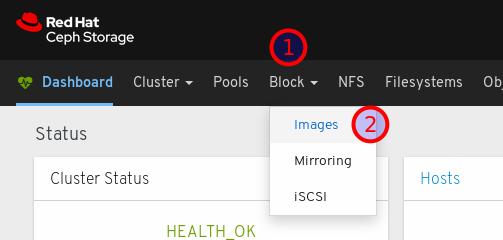

탐색 모음에서 블록을 클릭합니다.

드롭다운에서 이미지를 선택합니다.

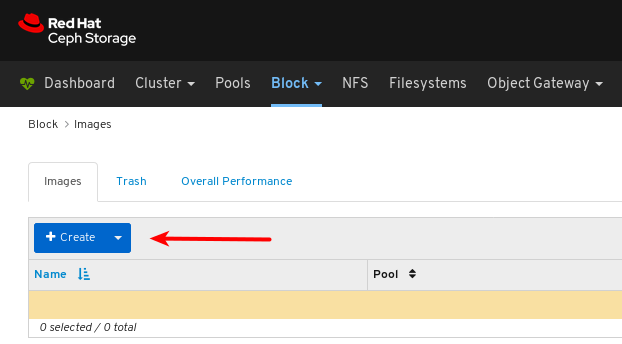

이미지 탭에서 생성 버튼을 클릭합니다.

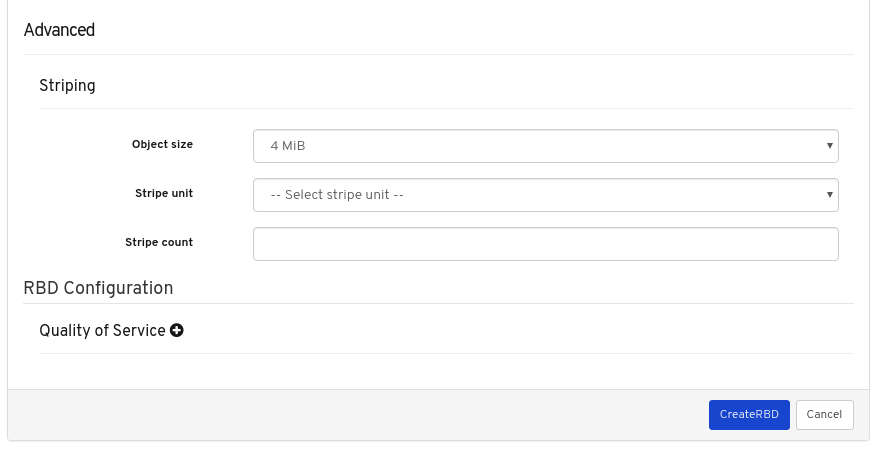

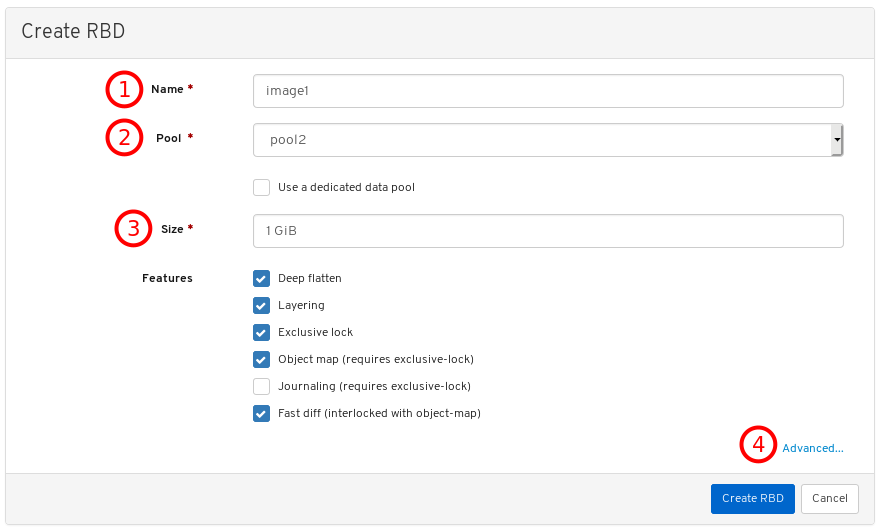

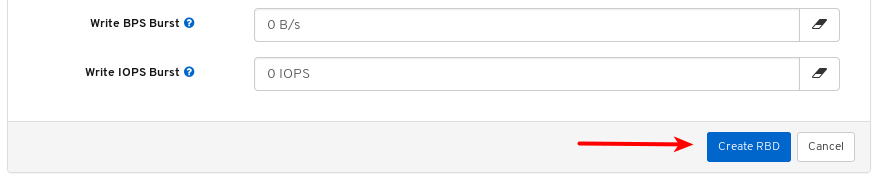

CreateRBD 창에서 매개변수를 입력합니다.

선택 사항: 고급 을 클릭하고 매개변수를 설정합니다.

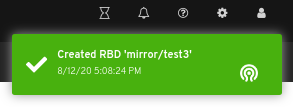

CreateRBD 버튼을 클릭합니다.

페이지 오른쪽 상단 모서리에 대한 알림은 이미지가 성공적으로 생성되었음을 나타냅니다.

추가 리소스

- 이미지에 대한 자세한 내용은 Red Hat Ceph Storage Block Device 가이드 를 참조하십시오.

- RBD 풀 생성에 대한 자세한 내용은 Red Hat Ceph Storage 대시보드 가이드 의 풀 생성 섹션을 참조하십시오.

9.2.3. 이미지 보기

대시보드를 사용하면 이미지를 볼 수 있습니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 대시보드가 설치되어 있습니다.

- 이미지는 클러스터에 있습니다.

절차

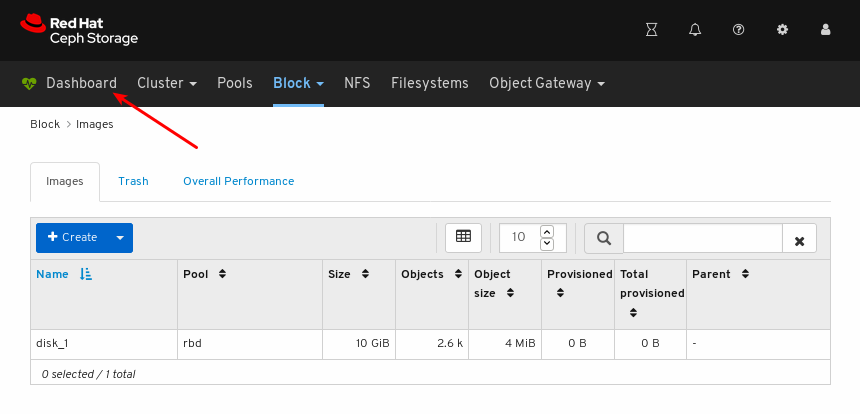

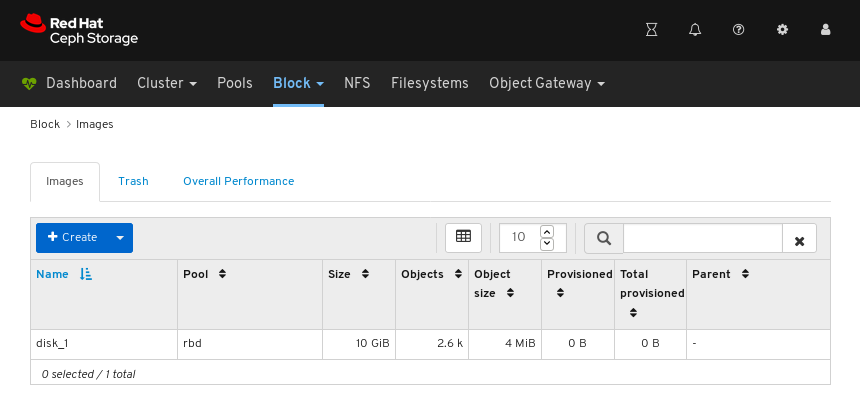

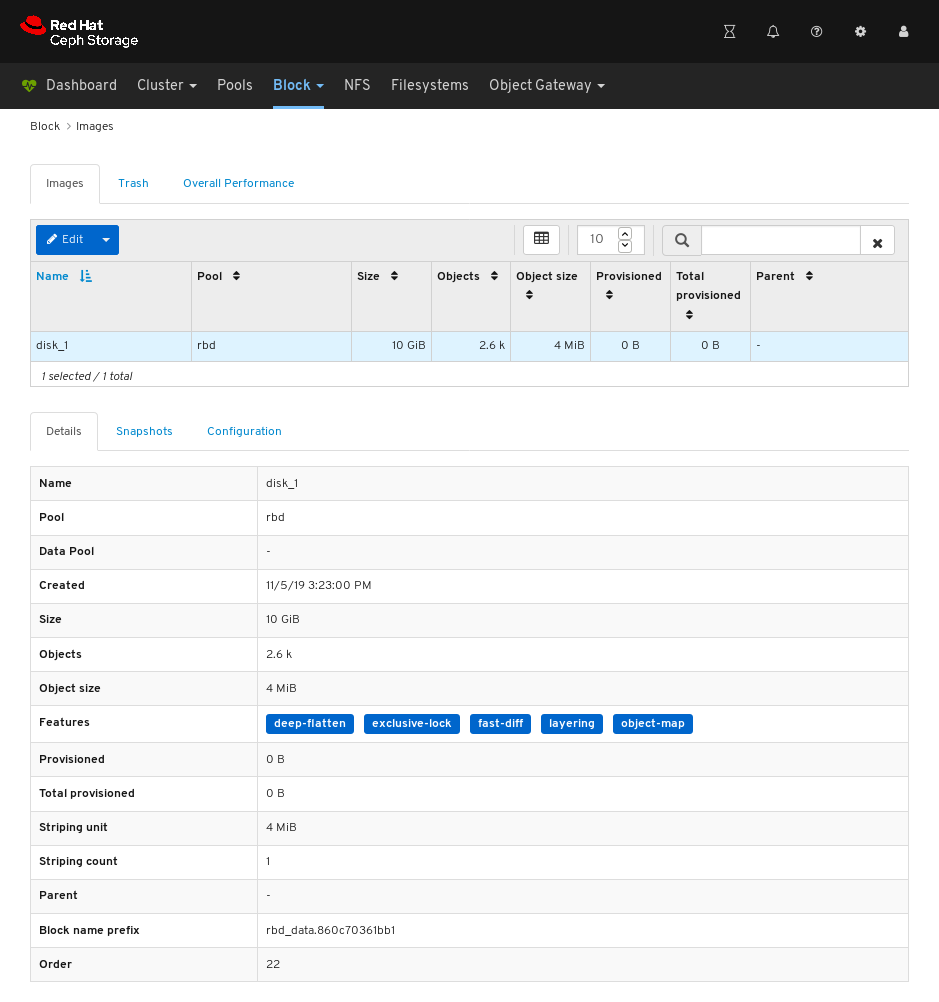

- 대시보드에 로그인합니다.

- 탐색 모음에서 블록 을 클릭합니다.On the navigation bar, click Block.

이미지를 클릭합니다.

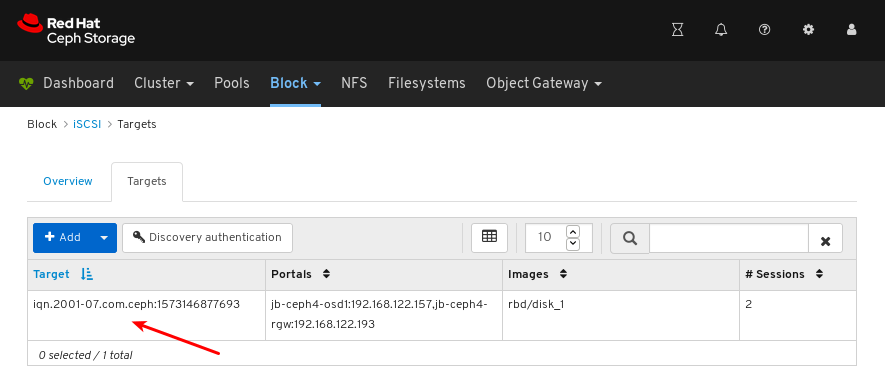

위의 예에서 disk_1 이라는 10GiB 이미지를 볼 수 있습니다.

자세한 내용을 보려면 disk_1 에 대한 행을 클릭하여 이미지를 선택합니다.

추가 리소스

- 이미지에 대한 자세한 내용은 블록 장치 가이드 를 참조하십시오.

9.2.4. 이미지 편집

대시보드를 사용하면 이미지를 편집할 수 있습니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 대시보드가 설치되어 있습니다.

- rbd 애플리케이션이 활성화된 풀이 생성됩니다.

- 이미지가 생성됩니다.

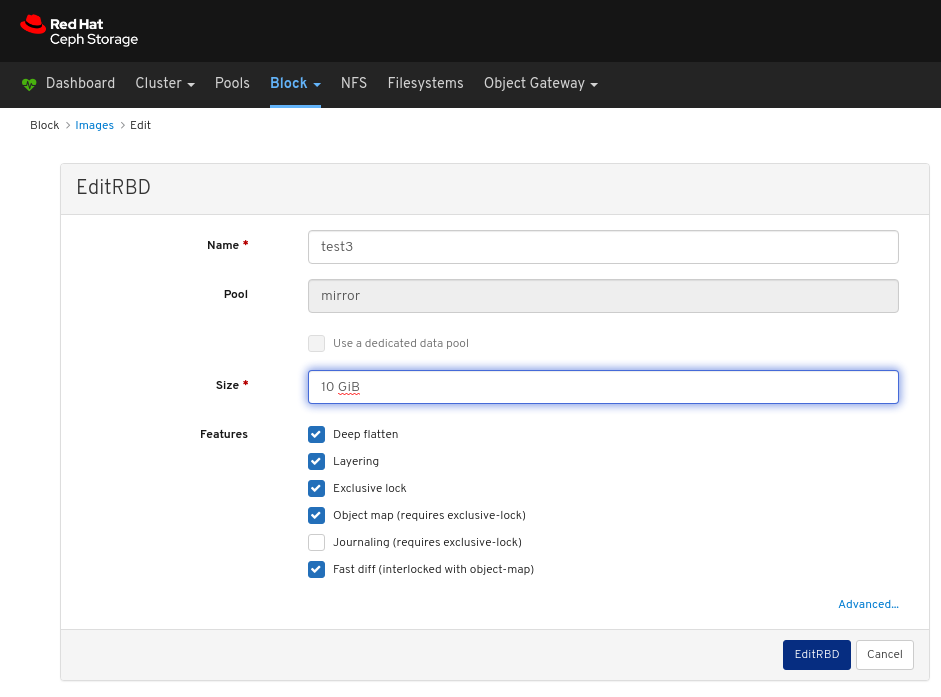

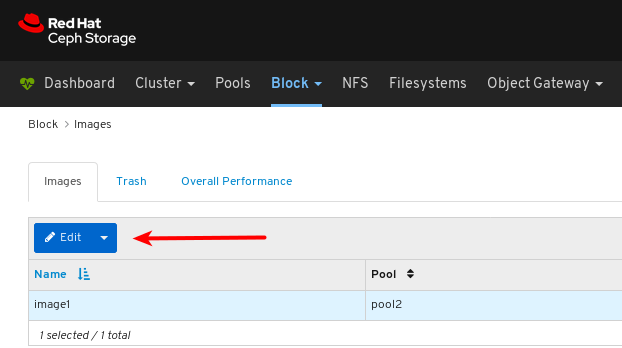

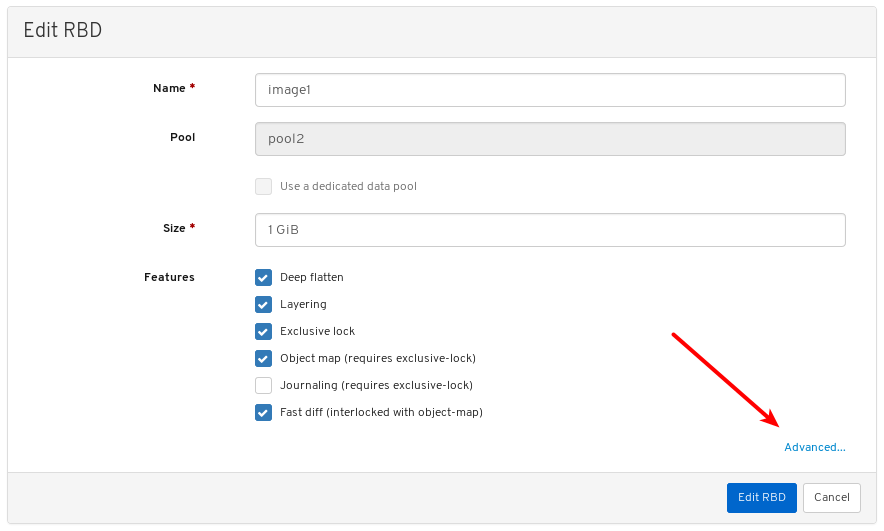

절차

- 대시보드에 로그인합니다.

탐색 모음에서 블록을 클릭합니다.On the navigation bar, click Block:

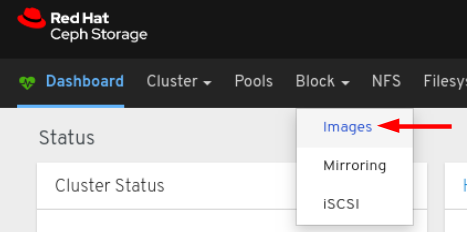

드롭다운에서 이미지를 선택합니다.

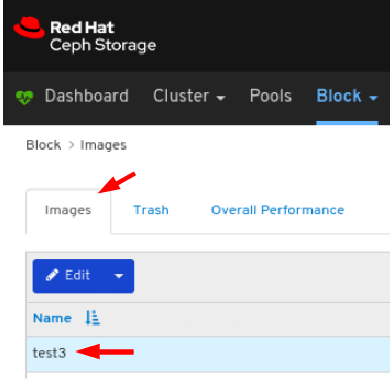

이미지를 편집하려면 Images (이미지) 탭에서 해당 행을 클릭합니다.

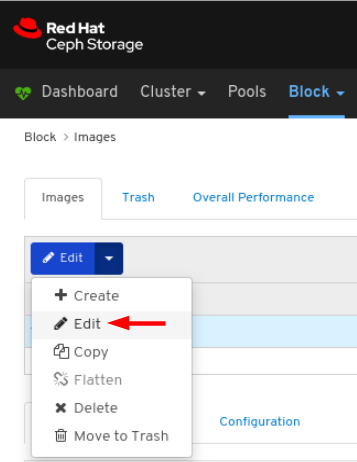

편집 드롭다운에서 편집 을 선택합니다.

RBD 편집 대화 상자에서 필요한 매개변수를 편집하고RBD 편집 버튼을 클릭합니다.

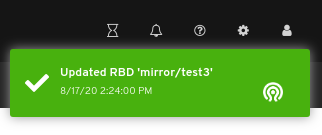

페이지 오른쪽 상단 모서리에 대한 알림은 이미지가 성공적으로 업데이트되었음을 나타냅니다.

추가 리소스

- 자세한 내용은 Red Hat Ceph Storage Dashboard Guide 의 Creating Images 섹션을 참조하십시오.

9.2.5. 이미지 복사

대시보드를 사용하면 이미지를 복사할 수 있습니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 대시보드가 설치되어 있습니다.

- rbd 애플리케이션이 활성화된 풀이 생성됩니다.

- 이미지가 생성됩니다.

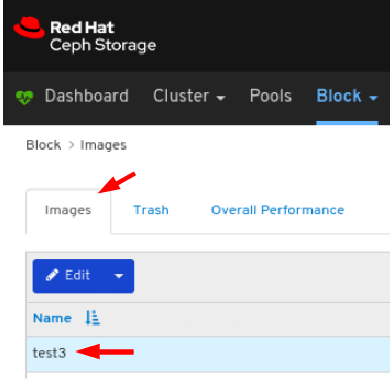

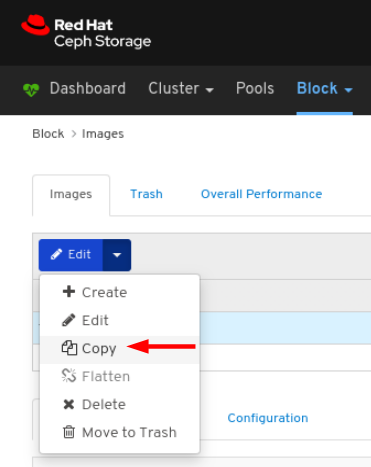

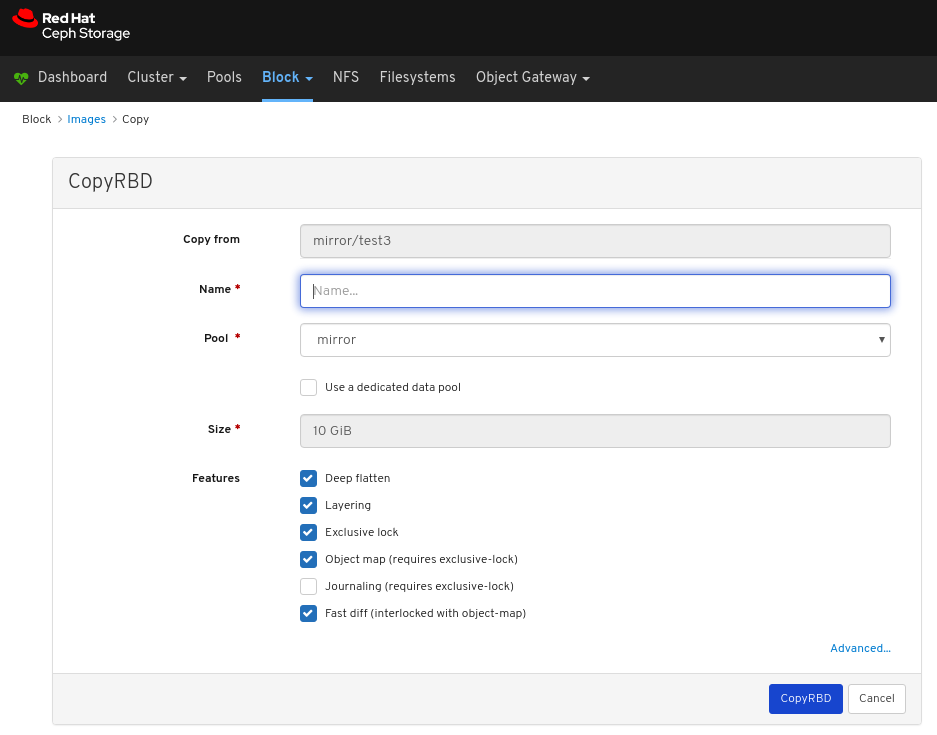

절차

- 대시보드에 로그인합니다.

탐색 모음에서 블록을 클릭합니다.On the navigation bar, click Block:

드롭다운에서 이미지를 선택합니다.

이미지를 복사하려면 Images (이미지) 탭에서 해당 행을 클릭합니다.

편집 드롭다운에서 복사 를 선택합니다.

CopyRBD 창에서 필요한 매개변수를 편집하고 CopyRBD 버튼을 클릭합니다.

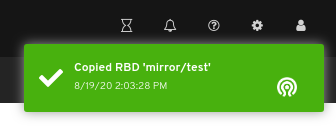

페이지 오른쪽 상단 모서리에 대한 알림은 이미지가 성공적으로 업데이트되었음을 나타냅니다.

추가 리소스

- 자세한 내용은 Red Hat Ceph Storage Dashboard Guide 의 Creating Images 섹션을 참조하십시오.

9.2.6. 트래치로 이미지 이동

대시보드를 사용하면 이미지를 휴지통으로 이동할 수 있습니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 대시보드가 설치되어 있습니다.

- rbd 애플리케이션이 활성화된 풀이 생성됩니다.

- 이미지가 생성됩니다.

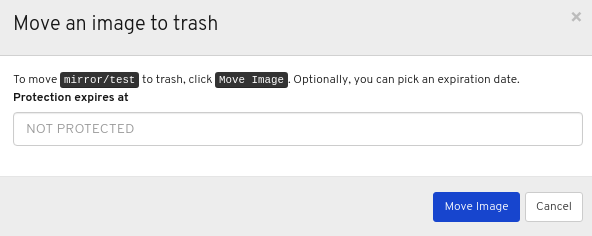

절차

- 대시보드에 로그인합니다.

탐색 모음에서 블록을 클릭합니다.On the navigation bar, click Block:

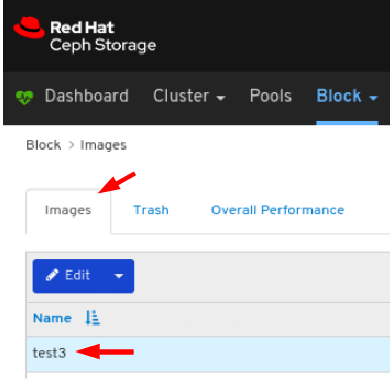

드롭다운에서 이미지를 선택합니다.

이미지를 bin으로 이동하려면 Images (이미지) 탭에서 해당 행을 클릭합니다.

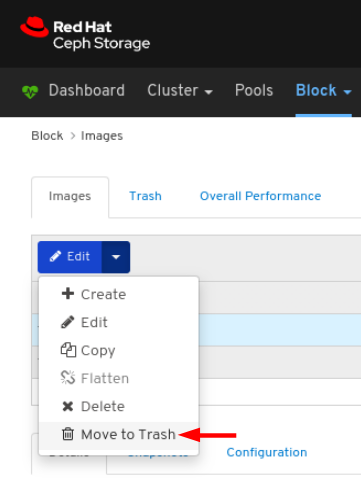

편집 드롭다운 에서 이동 을 선택합니다.

이미지를 휴지통으로 이동시킨 후 이미지가 보호가 필요한 날짜를 편집한 다음 Move Image (이미지 이동) 버튼을 클릭합니다.

페이지 오른쪽 상단 모서리에 대한 알림은 이미지가 휴지통으로 이동되었음을 나타냅니다.

9.2.7. 자주 묻는 질문

대시보드를 사용하면 이미지의 휴지통을 제거할 수 있습니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 대시보드가 설치되어 있습니다.

- rbd 애플리케이션이 활성화된 풀이 생성됩니다.

- 이미지가 손상되었습니다.

절차

- 대시보드에 로그인합니다.

탐색 모음에서 블록을 클릭합니다.On the navigation bar, click Block:

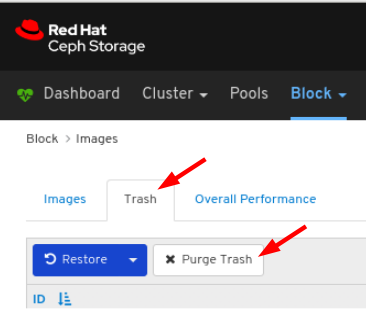

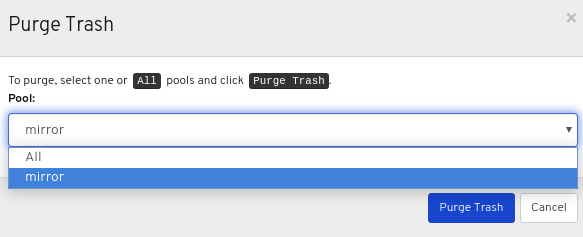

드롭다운에서 이미지를 선택합니다.

bin 탭에서 Purge bin 버튼을 클릭합니다.

Purge bin 창에서 풀을 선택한 다음 Purge bin 버튼을 클릭합니다.

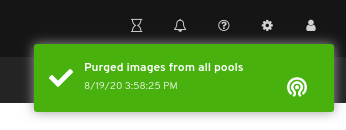

페이지 오른쪽 상단 모서리에 대한 알림은 선택한 풀에서 이미지가 성공적으로 제거되었음을 나타냅니다.

추가 리소스

- 자세한 내용은 Red Hat Ceph Storage 블록 장치 가이드의 블록 장치스냅샷 삭제 섹션을 참조하십시오.

9.2.8. 휴지통에서 이미지 복원

대시보드를 사용하면 destroy에서 이미지를 복원할 수 있습니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 대시보드가 설치되어 있습니다.

- rbd 애플리케이션이 활성화된 풀이 생성됩니다.

- 이미지가 손상되었습니다.

절차

- 대시보드에 로그인합니다.

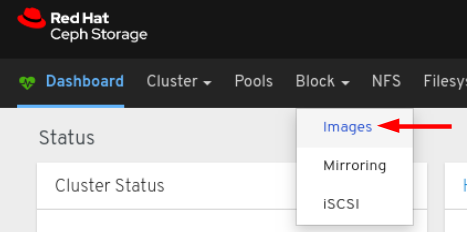

탐색 모음에서 블록을 클릭합니다.On the navigation bar, click Block:

드롭다운에서 이미지를 선택합니다.

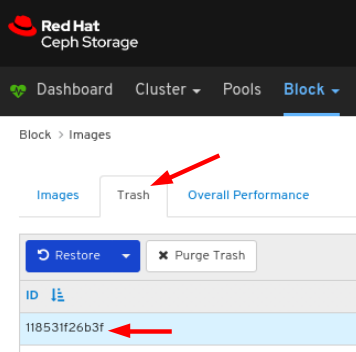

bin 탭에서 이미지를 복원하려면 해당 행을 클릭합니다.To restore the image from the bin tab, click its row:

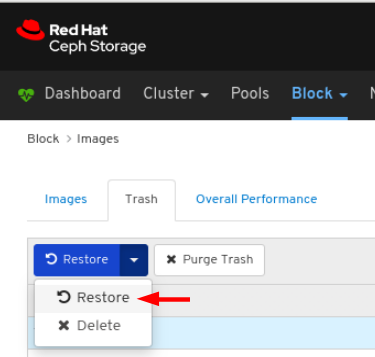

복원 드롭다운에서 복원을 선택합니다.Select Restore in the Restore drop-down:

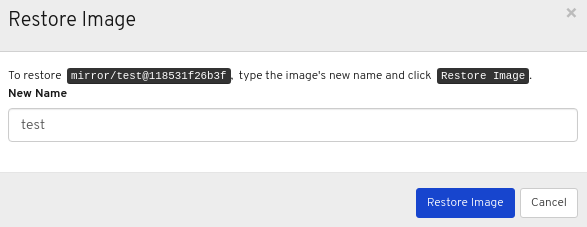

복원 이미지 창에서 이미지 이름을 입력하고 복원 이미지 버튼을 클릭합니다.

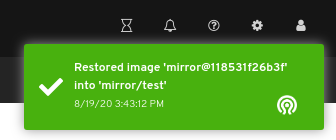

페이지의 오른쪽 상단 모서리에 대한 알림은 이미지가 휴지통에서 성공적으로 복원되었음을 나타냅니다.

추가 리소스

- RBD 풀에서 이미지를 만드는 방법에 대한 자세한 내용은 Red Hat Ceph Storage 대시보드 가이드 의 이미지 생성 섹션을 참조하십시오.

9.2.9. 이미지 삭제

대시보드를 사용하면 이미지를 삭제할 수 있습니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 대시보드가 설치되어 있습니다.

- rbd 애플리케이션이 활성화된 풀이 생성됩니다.

- 이미지가 생성됩니다.

절차

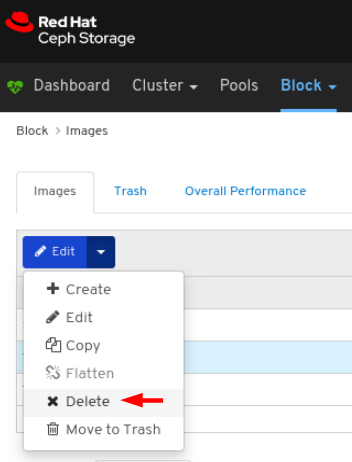

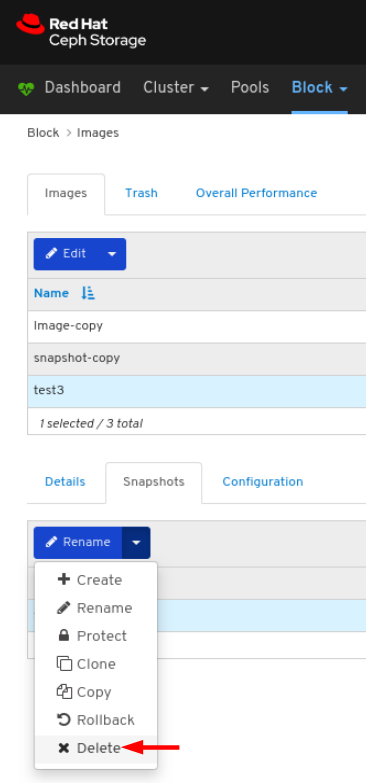

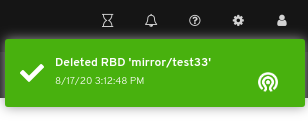

- 대시보드에 로그인합니다.

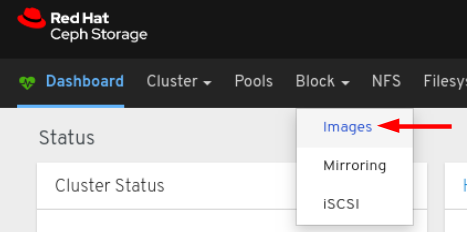

탐색 모음에서 블록을 클릭합니다.On the navigation bar, click Block:

드롭다운에서 이미지를 선택합니다.

이미지를 편집하려면 Images (이미지) 탭에서 해당 행을 클릭합니다.

편집 드롭다운에서 삭제를 선택합니다.

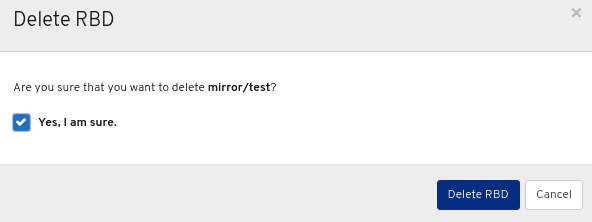

RBD 삭제 대화 상자 창에서 Yes, I am sure 상자를 클릭한 다음 RBD 삭제를 클릭하여 설정을 저장합니다.

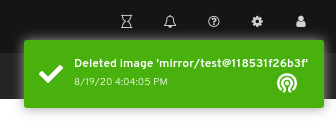

페이지 오른쪽 상단 모서리에 대한 알림은 이미지가 휴지통으로 이동되었음을 나타냅니다.

9.2.10. 이미지 스냅샷 생성

대시보드를 사용하면 Ceph 블록 장치 이미지의 스냅샷을 만들 수 있습니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 대시보드가 설치되어 있습니다.

- rbd 애플리케이션이 활성화된 풀이 생성됩니다.

- 이미지가 생성됩니다.

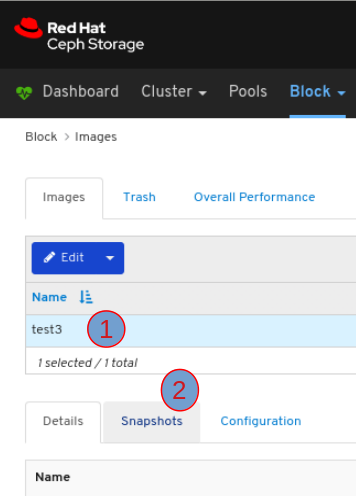

절차

- 대시보드에 로그인합니다.

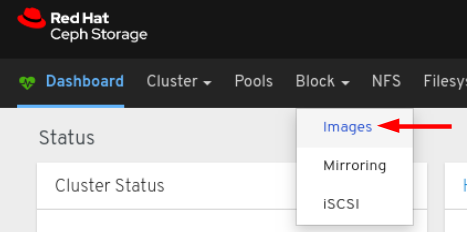

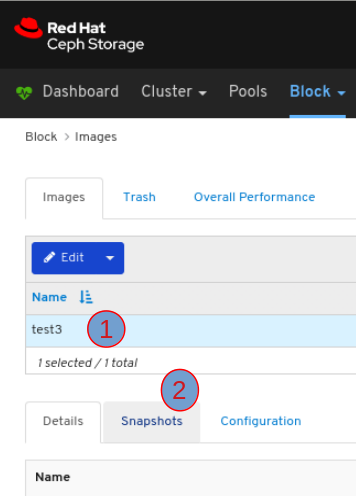

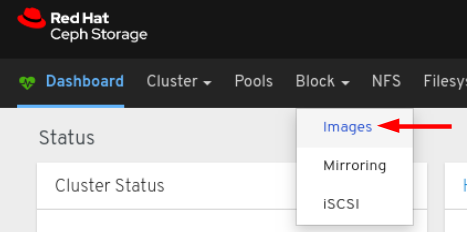

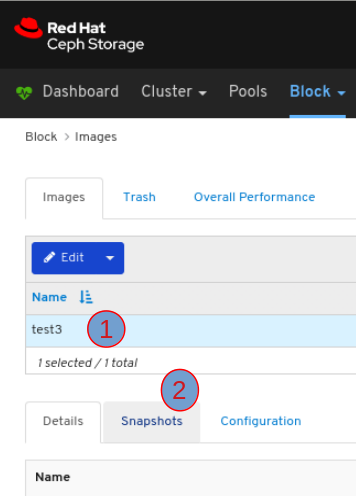

탐색 모음에서 블록을 클릭합니다.On the navigation bar, click Block:

드롭다운에서 이미지를 선택합니다.

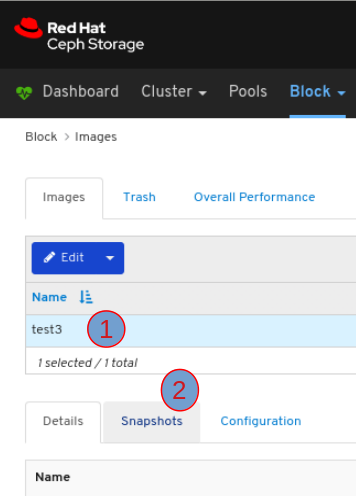

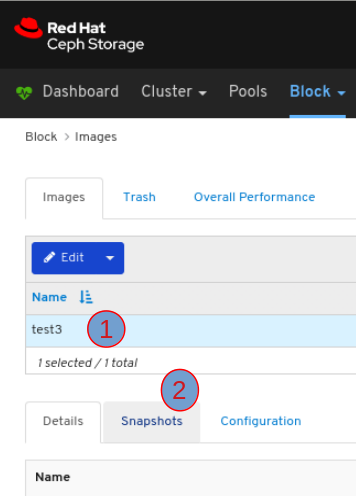

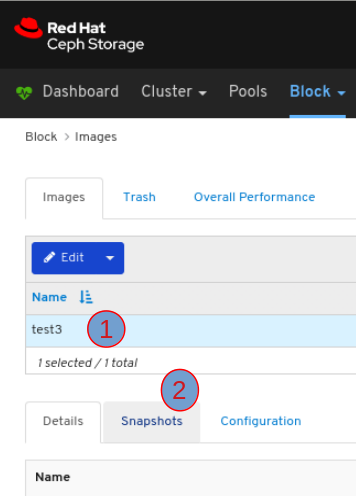

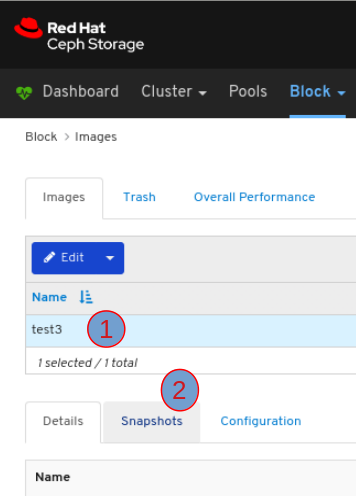

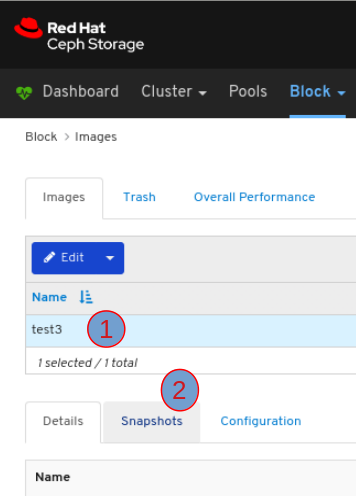

이미지의 스냅샷을 가져오려면 Images (이미지) 탭에서 해당 행을 클릭한 다음 Snapshots 탭을 클릭합니다.

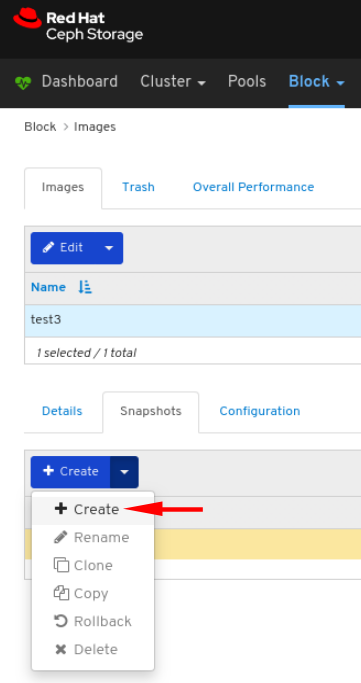

생성 드롭다운에서 생성을 선택합니다.

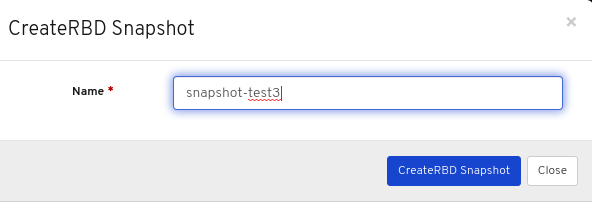

CreateRBD Snapshot 대화 상자에서 매개변수를 입력하고 CreateRBD Snapshot 버튼을 클릭합니다.

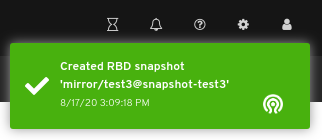

페이지 오른쪽 상단에 대한 알림은 이미지의 스냅샷이 성공적으로 생성되었음을 나타냅니다.

추가 리소스

- 스냅샷 생성에 대한 자세한 내용은 Red Hat Ceph Storage Block Device Guide의 블록 장치 스냅샷 생성 섹션을 참조하십시오.

- RBD 풀 생성에 대한 자세한 내용은 Red Hat Ceph Storage 대시보드 가이드 의 풀 생성 섹션을 참조하십시오.

- 자세한 내용은 Red Hat Ceph Storage 대시보드 가이드 의 이미지 생성 섹션을 참조하십시오.

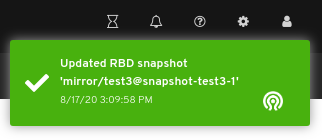

9.2.11. 이미지 스냅샷 이름 변경

대시보드를 사용하면 Ceph 블록 장치 이미지의 스냅샷의 이름을 변경할 수 있습니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 대시보드가 설치되어 있습니다.

- rbd 애플리케이션이 활성화된 풀이 생성됩니다.

- 이미지가 생성됩니다.

- 이미지의 스냅샷이 생성됩니다.

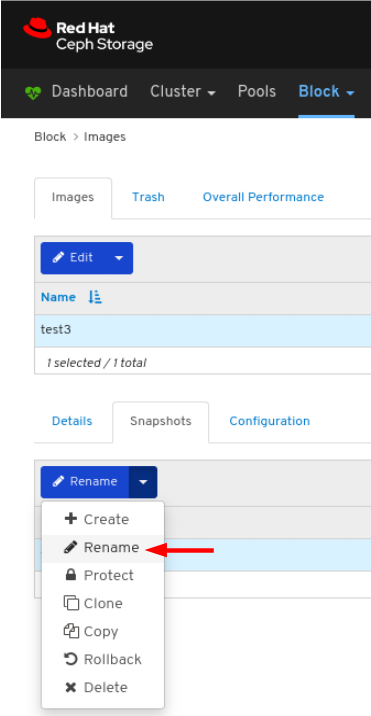

절차

- 대시보드에 로그인합니다.

탐색 모음에서 블록을 클릭합니다.On the navigation bar, click Block:

드롭다운에서 이미지를 선택합니다.

이미지 스냅샷의 이름을 변경하려면 Images (이미지) 탭에서 해당 행을 클릭한 다음 Snapshots 탭을 클릭합니다.

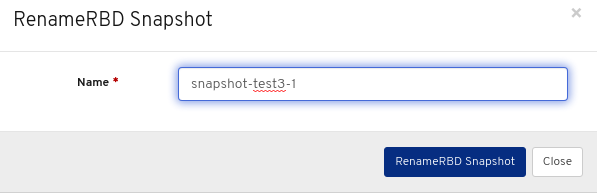

Rename 드롭다운에서 Rename 을 선택합니다.

RenameRBD Snapshot 대화 상자에서 매개변수를 입력하고 RenameRBD Snapshot 버튼을 클릭합니다.

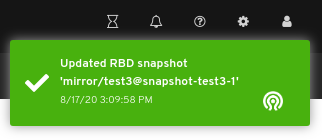

페이지 오른쪽 상단 모서리에 대한 알림은 이미지 스냅샷이 성공적으로 업데이트되었음을 나타냅니다.

추가 리소스

- 자세한 내용은 Red Hat Ceph Storage 블록 장치 가이드 ]의 블록 장치스냅샷 수정 섹션을 참조하십시오.

- RBD 풀 생성에 대한 자세한 내용은 Red Hat Ceph Storage 대시보드 가이드 의 풀 생성 섹션을 참조하십시오.

- RBD 풀에서 이미지를 만드는 방법에 대한 자세한 내용은 Red Hat Ceph Storage 대시보드 가이드 의 이미지 생성 섹션을 참조하십시오.

9.2.12. 이미지 스냅샷 보호

대시보드를 사용하면 Ceph 블록 장치 이미지의 스냅샷을 보호할 수 있습니다. 스냅샷을 복제해야 하는 경우 필요합니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 대시보드가 설치되어 있습니다.

- rbd 애플리케이션이 활성화된 풀이 생성됩니다.

- 이미지가 생성됩니다.

- 이미지의 스냅샷이 생성됩니다.

절차

- 대시보드에 로그인합니다.

탐색 모음에서 블록을 클릭합니다.On the navigation bar, click Block:

드롭다운에서 이미지를 선택합니다.

이미지의 스냅샷을 보호하려면 Images (이미지) 탭에서 해당 행을 클릭한 다음 Snapshots 탭을 클릭합니다.

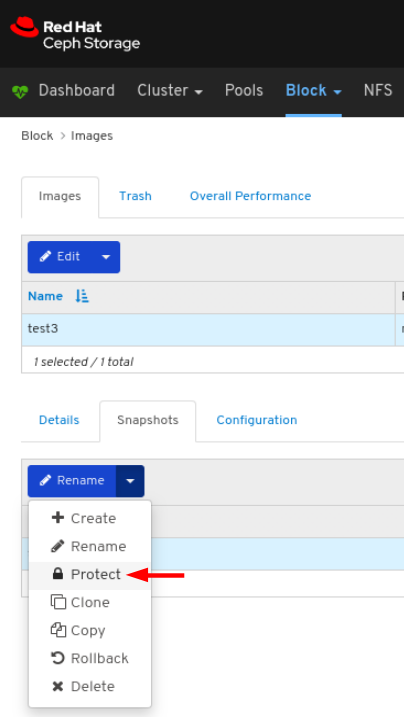

Rename 드롭다운에서 Protect 를 선택합니다.

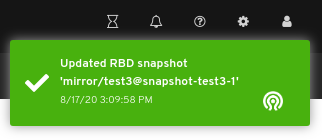

페이지 오른쪽 상단 모서리에 대한 알림은 이미지 스냅샷이 성공적으로 업데이트되었음을 나타냅니다.

추가 리소스

- 자세한 내용은 Red Hat Ceph Storage 블록 장치 가이드 ]의 블록 장치스냅샷 보호 섹션을 참조하십시오.

- RBD 풀 생성에 대한 자세한 내용은 Red Hat Ceph Storage 대시보드 가이드 의 풀 생성 섹션을 참조하십시오.

- RBD 풀에서 이미지를 만드는 방법에 대한 자세한 내용은 Red Hat Ceph Storage 대시보드 가이드 의 이미지 생성 섹션을 참조하십시오.

9.2.13. 이미지 스냅샷 복제

대시보드를 사용하면 Ceph 블록 장치 이미지의 스냅샷을 복제할 수 있습니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 대시보드가 설치되어 있습니다.

- rbd 애플리케이션이 활성화된 풀이 생성됩니다.

- 이미지가 생성됩니다.

- 이미지의 스냅샷이 생성됩니다.

- 이미지의 스냅샷이 보호됩니다.

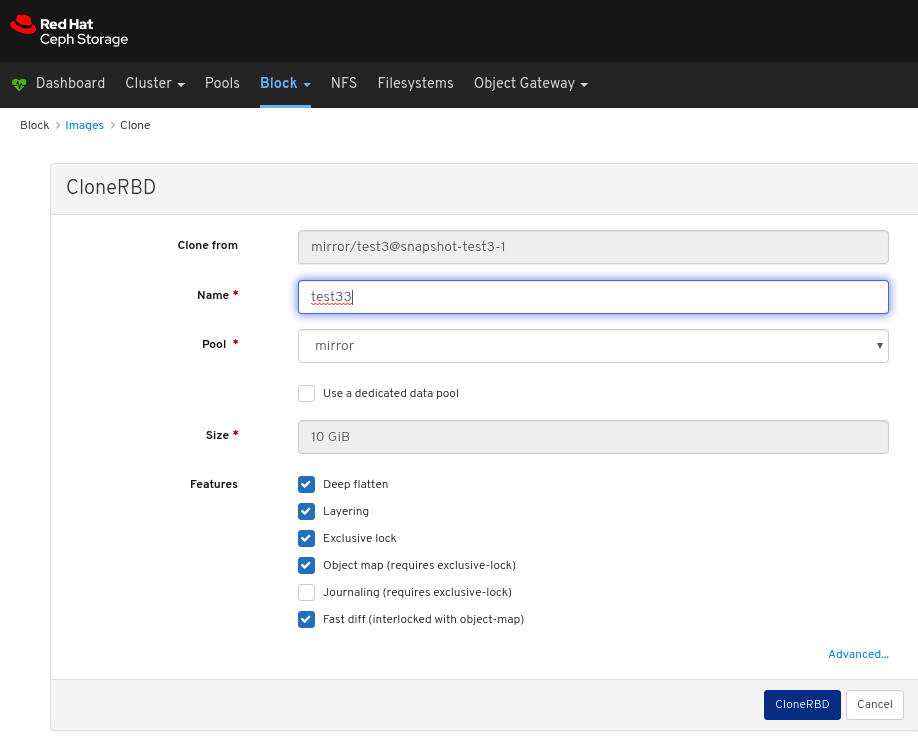

절차

- 대시보드에 로그인합니다.

탐색 모음에서 블록을 클릭합니다.On the navigation bar, click Block:

드롭다운에서 이미지를 선택합니다.

이미지의 스냅샷을 복제하려면 Images (이미지) 탭에서 해당 행을 클릭한 다음 Snapshots 탭을 클릭합니다.

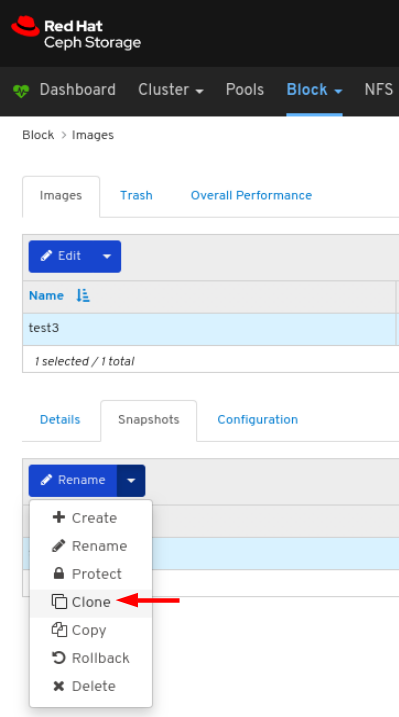

이름 드롭다운에서 복제 를 선택합니다.

CloneRBD 대화 상자에서 매개변수를 입력하고 CloneRBD 버튼을 클릭합니다.

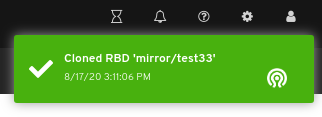

페이지 오른쪽 상단 모서리에 대한 알림은 이미지의 스냅샷이 성공적으로 복제되었음을 나타냅니다.

추가 리소스

- 자세한 내용은 Red Hat Ceph Storage 블록 장치 가이드 ]의 블록 장치스냅샷 수정 섹션을 참조하십시오.

- 자세한 내용은 Red Hat Ceph Storage 블록 장치 가이드의 블록 장치스냅샷 보호 섹션을 참조하십시오.

- RBD 풀 생성에 대한 자세한 내용은 Red Hat Ceph Storage 대시보드 가이드 의 풀 생성 섹션을 참조하십시오.

- RBD 풀에서 이미지를 만드는 방법에 대한 자세한 내용은 Red Hat Ceph Storage 대시보드 가이드 의 이미지 생성 섹션을 참조하십시오.

- 자세한 내용은 Red Hat Ceph Storage 대시보드 가이드 의 이미지 스냅샷 보호 섹션을 참조하십시오.

9.2.14. 이미지 스냅샷 복사

대시보드를 사용하면 Ceph 블록 장치 이미지의 스냅샷을 복사할 수 있습니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 대시보드가 설치되어 있습니다.

- rbd 애플리케이션이 활성화된 풀이 생성됩니다.

- 이미지가 생성됩니다.

- 이미지의 스냅샷이 생성됩니다.

절차

- 대시보드에 로그인합니다.

탐색 모음에서 블록을 클릭합니다.On the navigation bar, click Block:

드롭다운에서 이미지를 선택합니다.

이미지의 스냅샷을 복사하려면 Images (이미지) 탭에서 해당 행을 클릭한 다음 Snapshots 탭을 클릭합니다.

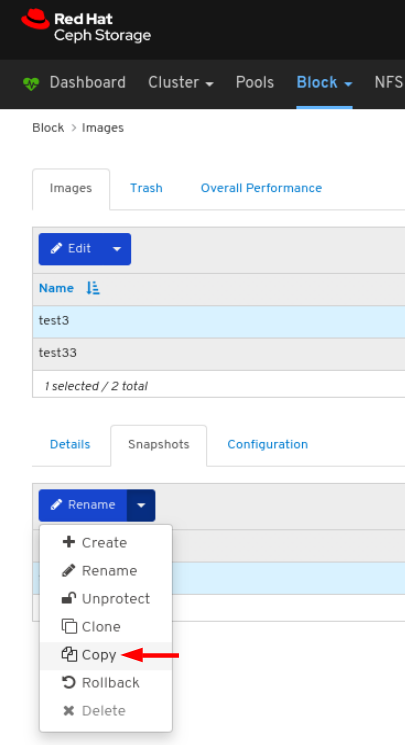

복원 드롭다운에서 복사를 선택합니다.Select Copy in the Rename drop-down:

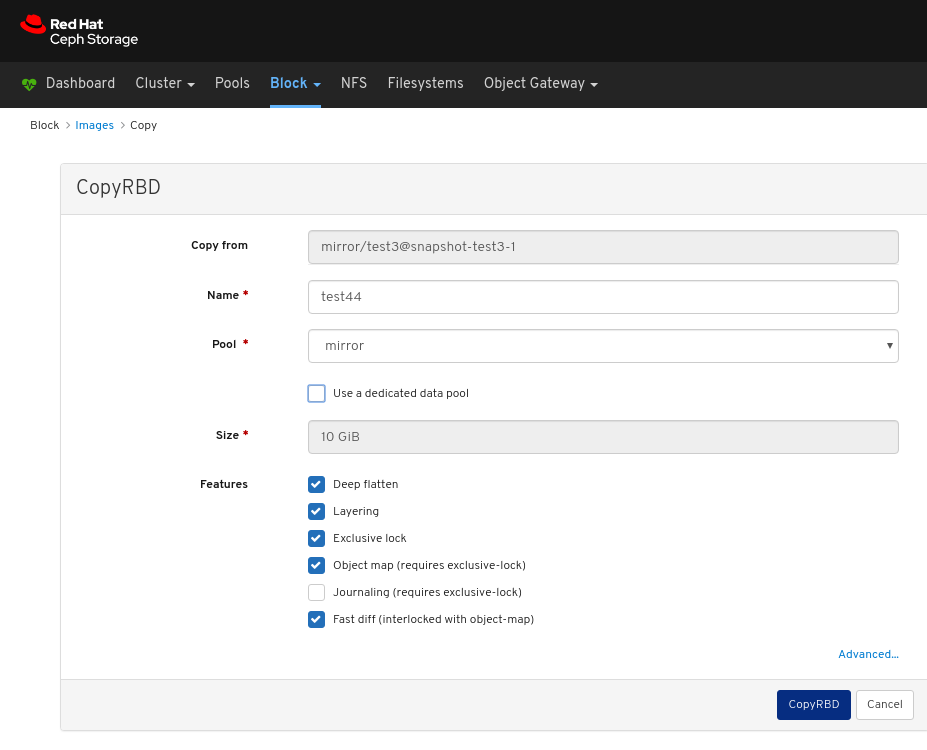

복사RBD 대화 상자에서 매개변수를 입력하고 CopyRBD 버튼을 클릭합니다.

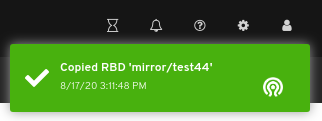

페이지 오른쪽 상단 모서리에 대한 알림은 이미지 스냅샷이 성공적으로 업데이트되었음을 나타냅니다.

9.2.15. 이미지 스냅샷 롤백

대시보드를 사용하면 Ceph 블록 장치 이미지의 스냅샷을 롤백할 수 있습니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 대시보드가 설치되어 있습니다.

- rbd 애플리케이션이 활성화된 풀이 생성됩니다.

- 이미지가 생성됩니다.

- 이미지의 스냅샷이 생성됩니다.

절차

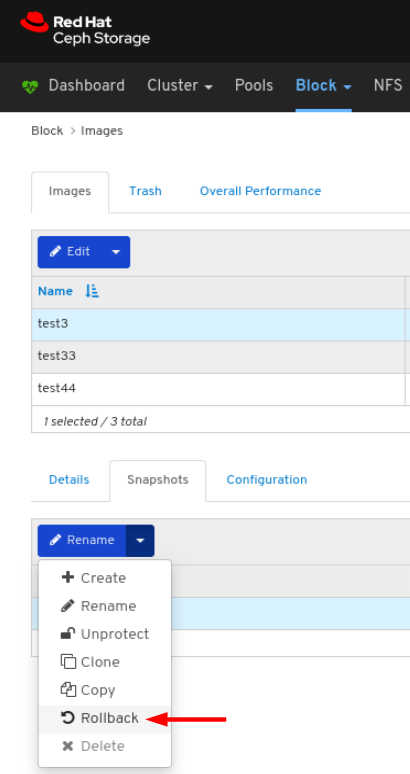

- 대시보드에 로그인합니다.

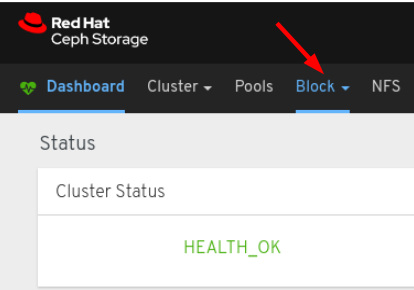

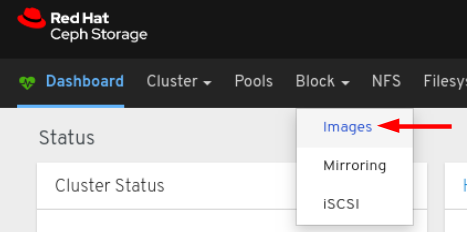

탐색 모음에서 블록을 클릭합니다.On the navigation bar, click Block:

드롭다운에서 이미지를 선택합니다.

이미지의 스냅샷을 롤백하려면 Images (이미지) 탭에서 해당 행을 클릭한 다음 Snapshots 탭을 클릭합니다.

이름 드롭다운에서 롤백 을 선택합니다.

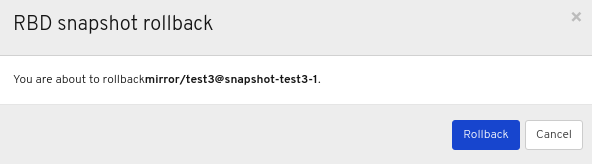

RBD 스냅샷 롤백 창에서 롤백 버튼을 클릭합니다.

페이지 오른쪽 상단 모서리에 대한 알림은 이미지의 스냅샷이 성공적으로 롤백되었음을 나타냅니다.

추가 리소스

- 자세한 내용은 Red Hat Ceph Storage 블록 장치 가이드 ]의 블록 장치스냅샷 롤링 섹션을 참조하십시오.

- 자세한 내용은 Red Hat Ceph Storage 대시보드 가이드 의 풀 생성 섹션을 참조하십시오.

- 자세한 내용은 Red Hat Ceph Storage 대시보드 가이드 의 이미지 생성 섹션을 참조하십시오.

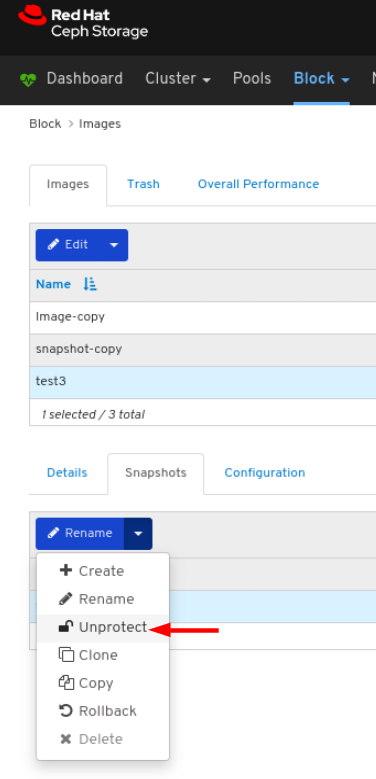

9.2.16. 이미지 스냅샷 보호 해제

대시보드를 사용하면 Ceph 블록 장치 이미지의 스냅샷을 보호 해제할 수 있습니다. 스냅샷을 삭제해야 하는 경우 필요합니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 대시보드가 설치되어 있습니다.

- rbd 애플리케이션이 활성화된 풀이 생성됩니다.

- 이미지가 생성됩니다.

- 이미지의 스냅샷이 생성됩니다.

- 이미지의 스냅샷이 보호됩니다.

절차

- 대시보드에 로그인합니다.

탐색 모음에서 블록을 클릭합니다.On the navigation bar, click Block:

드롭다운에서 이미지를 선택합니다.

이미지의 스냅샷을 보호하려면 Images (이미지) 탭에서 해당 행을 클릭한 다음 Snapshots 탭을 클릭합니다.

Rename 드롭다운에서 UnProtect 를 선택합니다.

페이지 오른쪽 상단 모서리에 대한 알림은 이미지 스냅샷이 성공적으로 업데이트되었음을 나타냅니다.

추가 리소스

- 자세한 내용은 Red Hat Ceph Storage 블록 장치 가이드의 블록 장치스냅샷 보호 섹션을 참조하십시오.

- RBD 풀 생성에 대한 자세한 내용은 Red Hat Ceph Storage 대시보드 가이드 의 풀 생성 섹션을 참조하십시오.

- RBD 풀에서 이미지를 만드는 방법에 대한 자세한 내용은 Red Hat Ceph Storage 대시보드 가이드 의 이미지 생성 섹션을 참조하십시오.

- 자세한 내용은 Red Hat Ceph Storage 대시보드 가이드 의 이미지 스냅샷 보호 섹션을 참조하십시오.

9.2.17. 이미지 스냅샷 삭제

대시보드를 사용하면 Ceph 블록 장치 이미지의 스냅샷을 삭제할 수 있습니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 대시보드가 설치되어 있습니다.

- rbd 애플리케이션이 활성화된 풀이 생성됩니다.

- 이미지가 생성됩니다.

- 이미지의 스냅샷이 생성됩니다.

- 이미지 스냅샷이 보호되지 않습니다.

절차

- 대시보드에 로그인합니다.

탐색 모음에서 블록을 클릭합니다.On the navigation bar, click Block:

드롭다운에서 이미지를 선택합니다.

이미지의 스냅샷을 삭제하려면 Images (이미지) 탭에서 해당 행을 클릭한 다음 Snapshots 탭을 클릭합니다.

Rename 드롭다운에서 삭제를 선택합니다.

페이지 오른쪽 상단 모서리에 대한 알림은 이미지 스냅샷이 성공적으로 업데이트되었음을 나타냅니다.

추가 리소스

- 자세한 내용은 Red Hat Ceph Storage 블록 장치 가이드 ]의 블록 장치스냅샷 삭제 섹션을 참조하십시오.

- 자세한 내용은 Red Hat Ceph Storage 대시보드 가이드 의 이미지 스냅샷 보호 해제 섹션을 참조하십시오.

9.3. 미러링 함수

대시보드를 사용하면 미러링 기능을 관리하고 모니터링할 수 있습니다.

9.3.1. 사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 대시보드가 설치되어 있습니다.

9.3.2. 미러링 보기

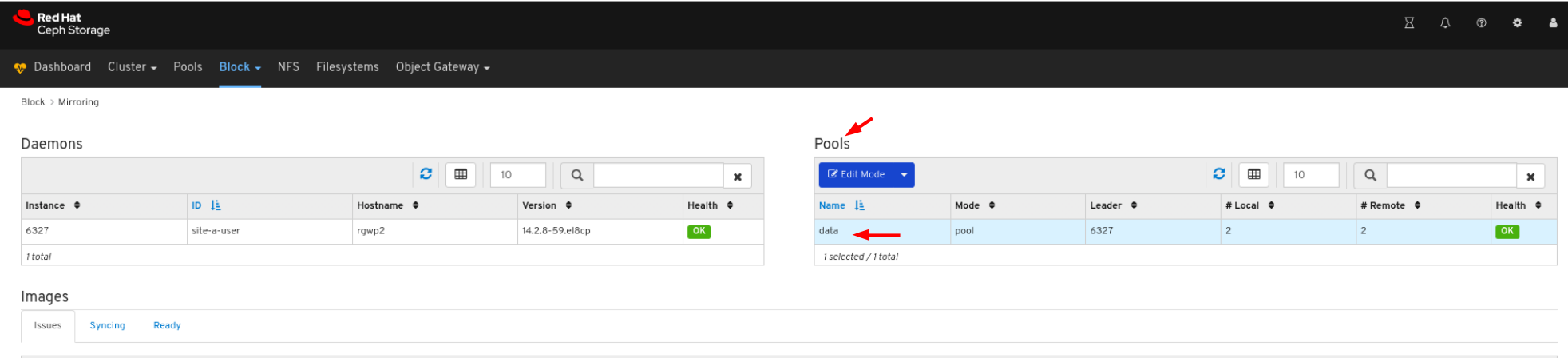

대시보드를 사용하면 미러링 기능의 전반적인 상태를 볼 수 있습니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 대시보드가 설치되어 있습니다.

- 미러링이 구성되어 있습니다.

절차

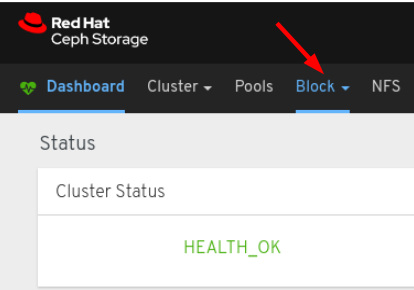

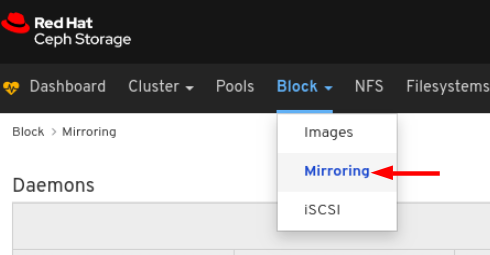

- 대시보드에 로그인합니다.

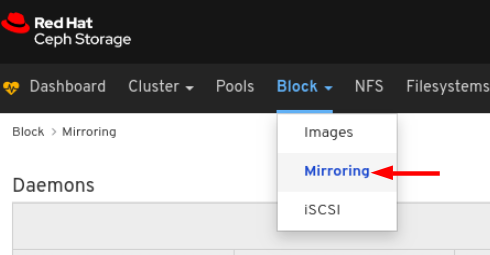

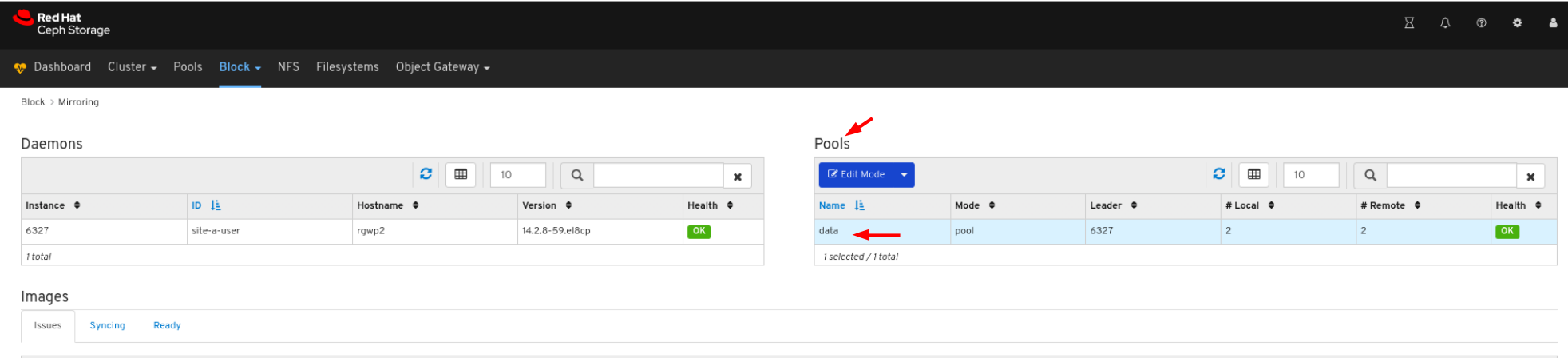

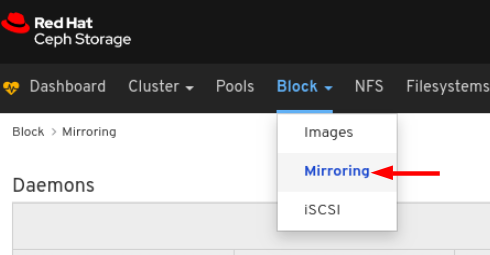

- 탐색 모음에서 블록 을 클릭합니다.On the navigation bar, click Block.

미러링 을 클릭합니다.

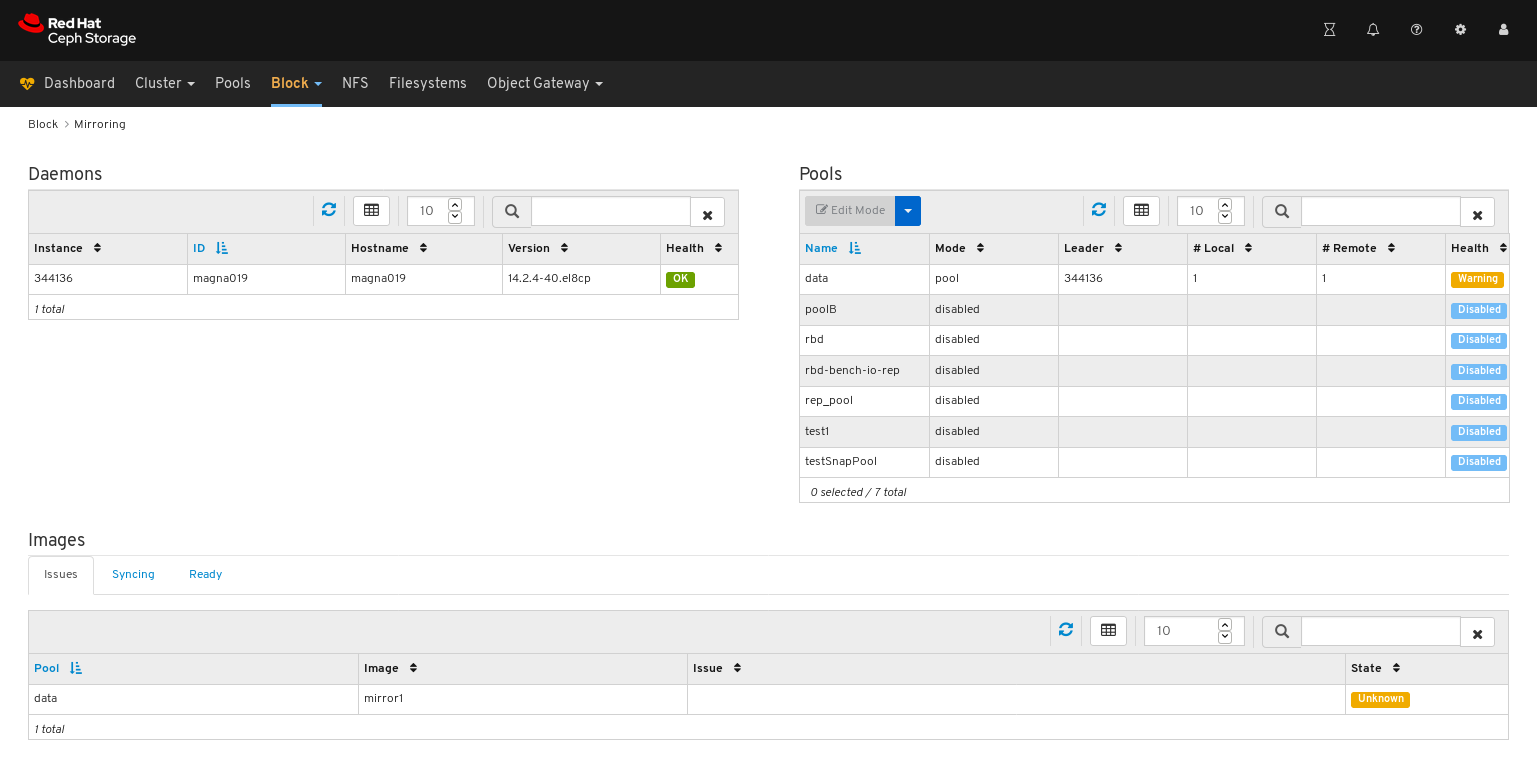

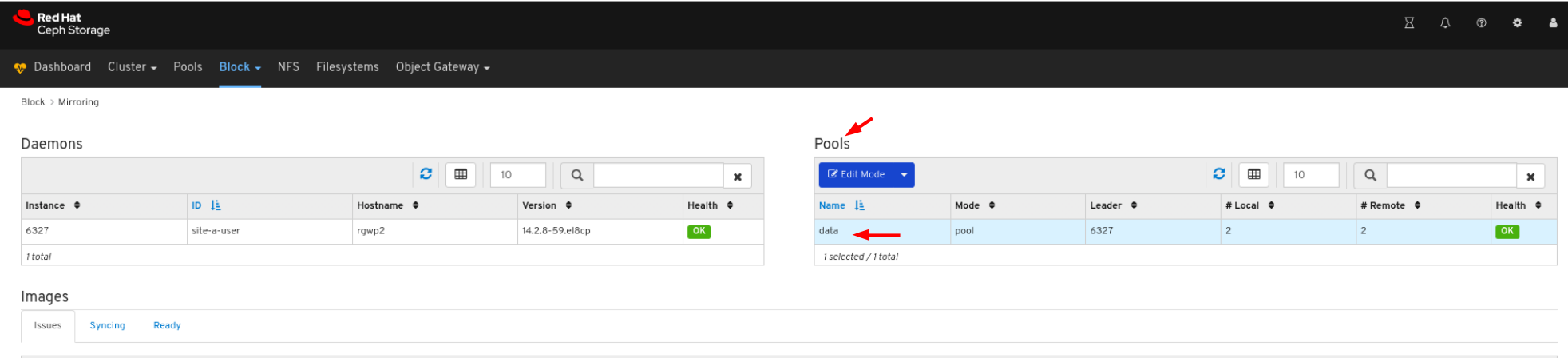

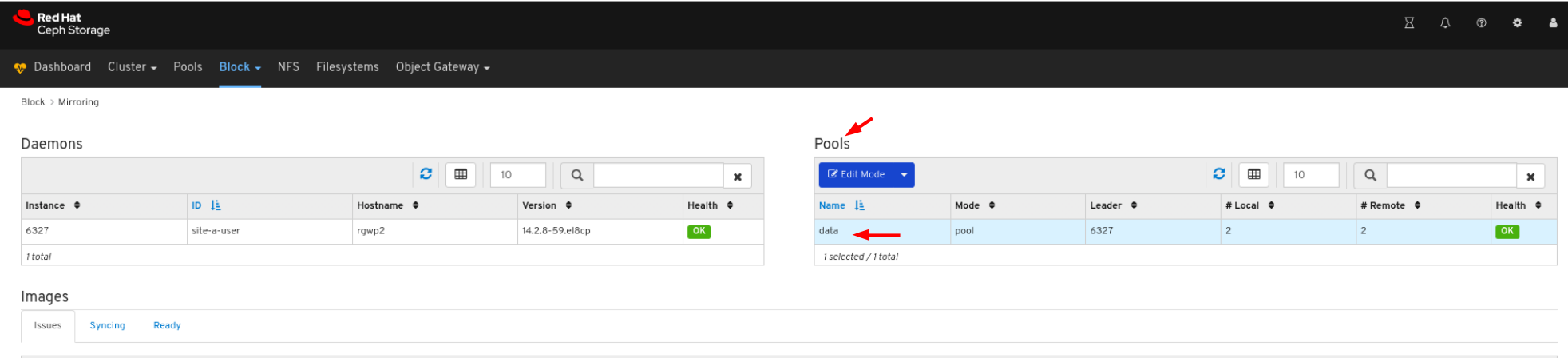

위의 예에서 Daemons,Pools, and Images 라는 레이블이 지정된 테이블로 분류된 미러링 정보를 확인할 수 있습니다.

추가 리소스

- 미러링에 대한 자세한 내용은 블록 장치 가이드의 Block Device Mirroring 을 참조하십시오.

9.3.3. 편집 모드

대시보드를 사용하면 풀 및 이미지를 포함하는 전체 미러링 기능 상태를 편집할 수 있습니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 대시보드가 설치되어 있습니다.

- rbd 애플리케이션이 활성화된 풀이 생성됩니다.

- 이미지가 생성됩니다.

- 미러링이 구성되어 있습니다.

절차

- 대시보드에 로그인합니다.

탐색 모음에서 블록을 클릭합니다.On the navigation bar, click Block:

드롭다운에서 미러링 을 클릭합니다.

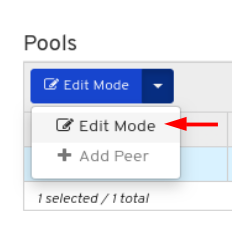

Pools 탭에서 행을 클릭합니다.

Edit Mode 드롭다운에서 Edit Mode 를 선택합니다.

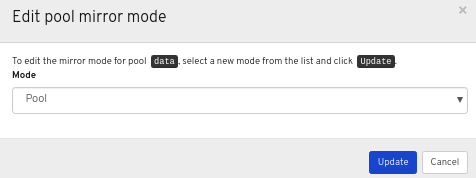

풀 미러 편집 모드 창의 드롭다운에서 모드를 선택한 다음 업데이트 버튼을 클릭합니다.

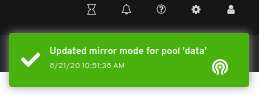

페이지 오른쪽 상단 모서리에 대한 알림은 미러 모드가 성공적으로 업데이트되었음을 나타냅니다.

추가 리소스

- 자세한 내용은 Red Hat Ceph Storage Block Device Guide 의 Ceph Block Device Mirroring 섹션을 참조하십시오.

9.3.4. 미러링에 피어 추가

대시보드를 사용하면'rbd-daemon' 미러에 대한 스토리지 클러스터 피어를 추가하여 피어 스토리지 클러스터를 검색할 수 있습니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 대시보드가 설치되어 있습니다.

- rbd 애플리케이션이 활성화된 풀이 생성됩니다.

- 이미지가 생성됩니다.

- 미러링이 구성되어 있습니다.

절차

- 대시보드에 로그인합니다.

탐색 모음에서 블록을 클릭합니다.On the navigation bar, click Block:

드롭다운에서 미러링 을 클릭합니다.

풀 탭에서 행을 클릭합니다.

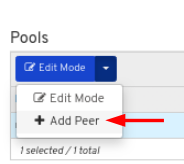

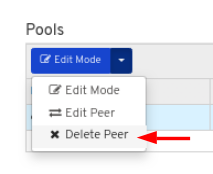

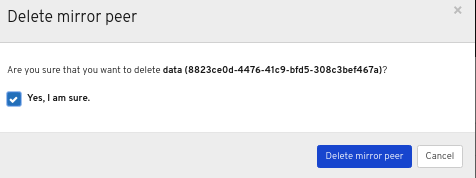

편집 모드 드롭다운에서 피어 추가 를 선택합니다.

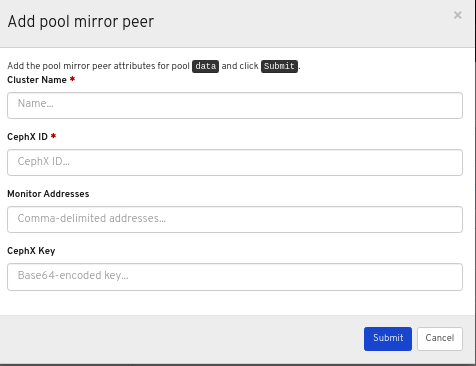

Add pool mirror peer 창에 매개 변수를 입력한 다음 Submit (제출) 버튼을 클릭합니다.

페이지 오른쪽 상단 모서리에 대한 알림은 미러 피어가 성공적으로 생성되었음을 나타냅니다.

추가 리소스

- 자세한 내용은 Red Hat Ceph Storage Block Device 가이드 의 스토리지 클러스터 피어 추가 섹션을 참조하십시오.

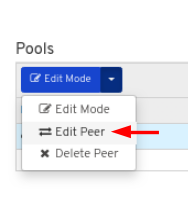

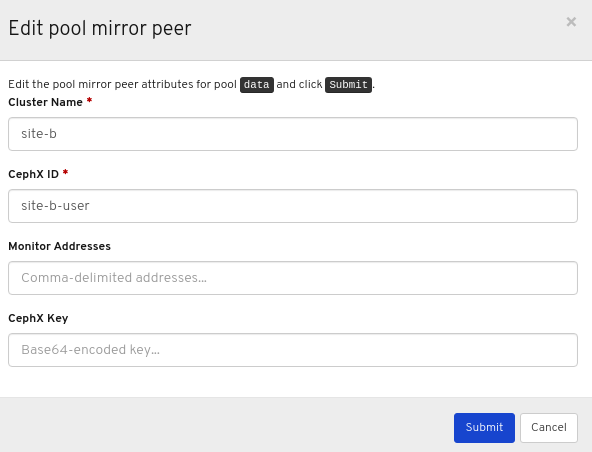

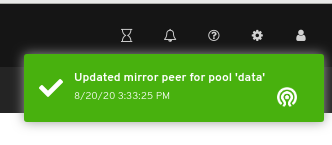

9.3.5. 미러링에서 피어 편집

대시보드를 사용하면'rbd-daemon' 미러의 스토리지 클러스터 피어를 편집하여 피어 스토리지 클러스터를 검색할 수 있습니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 대시보드가 설치되어 있습니다.

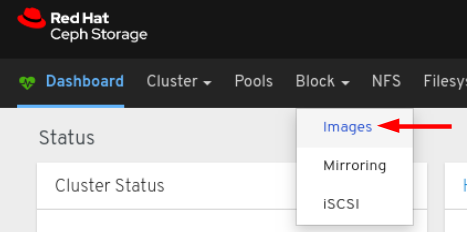

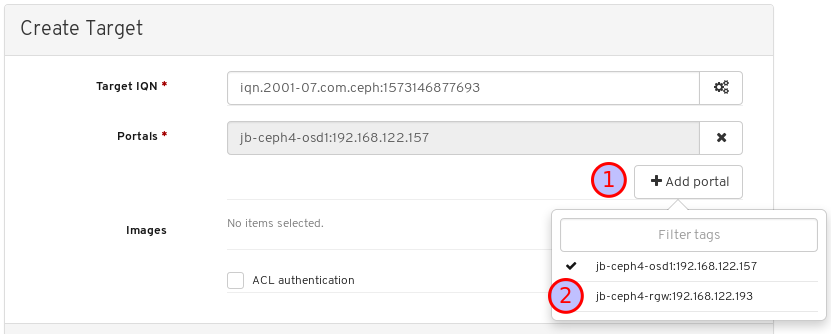

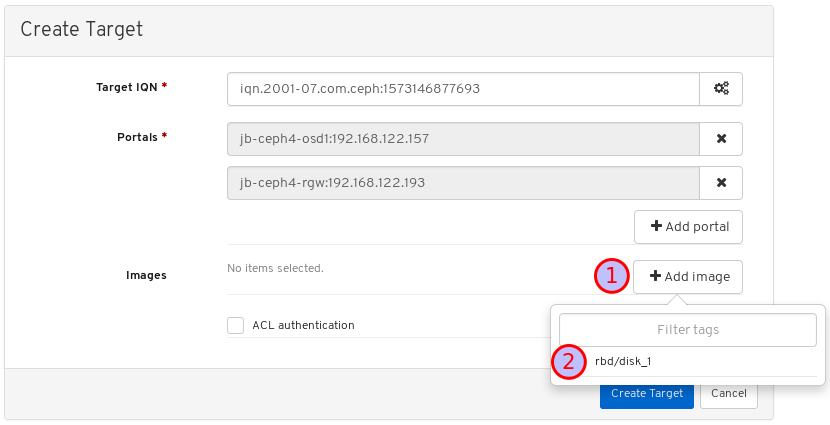

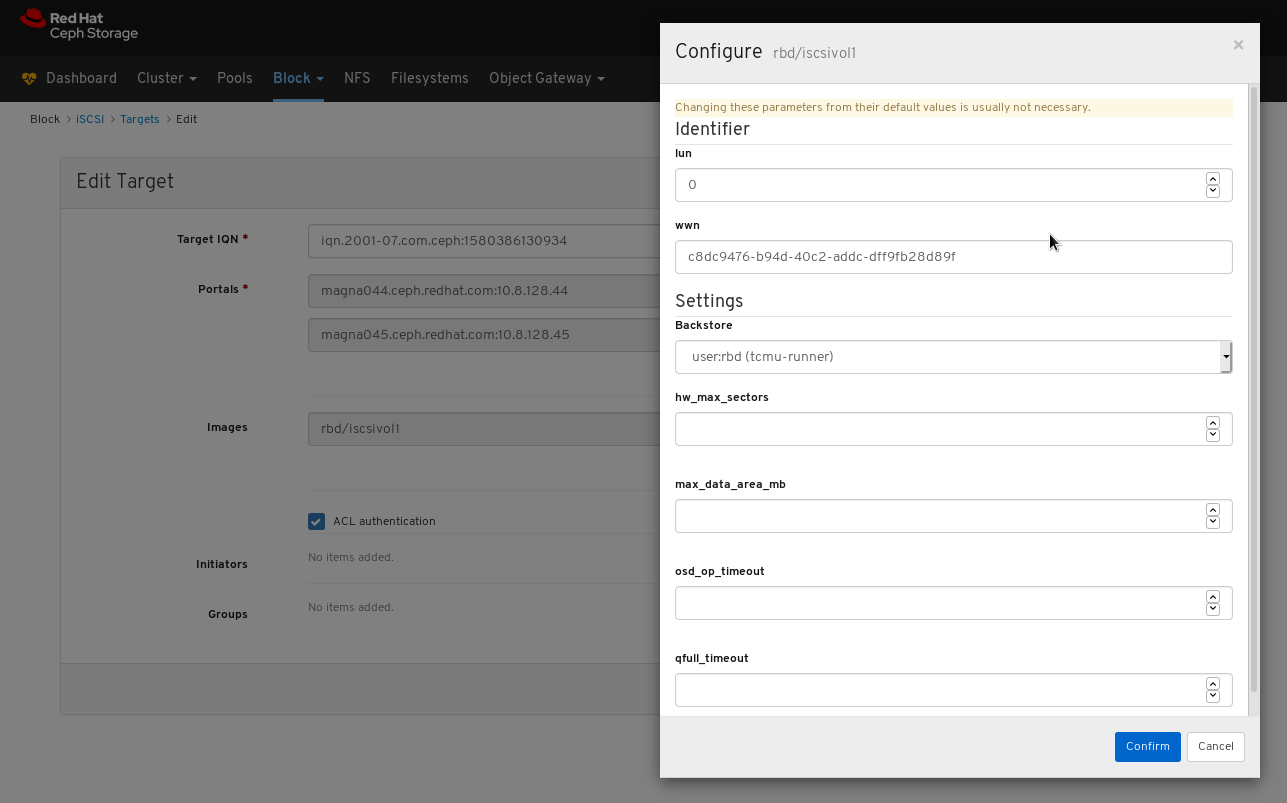

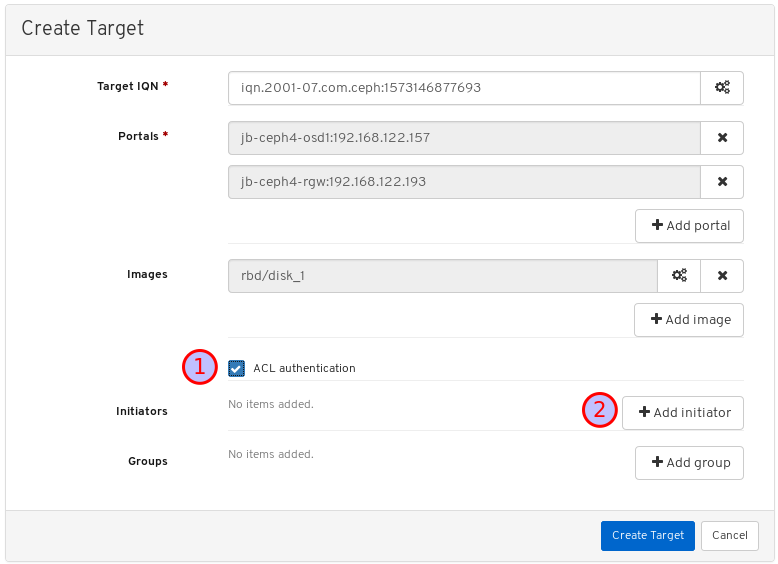

- rbd 애플리케이션이 활성화된 풀이 생성됩니다.