블록 장치 가이드

Red Hat Ceph Storage 블록 장치 관리, 생성, 구성 및 사용

초록

1장. Ceph 블록 장치 소개

블록은 시퀀스의 바이트 집합 길이입니다(예: 데이터의 512바이트 블록). 여러 블록을 단일 파일로 결합하면 읽고 쓸 수 있는 스토리지 장치로 사용할 수 있습니다. 블록 기반 스토리지 인터페이스는 다음과 같은 회전 미디어를 사용하여 데이터를 저장하는 가장 일반적인 방법입니다.

- 하드 드라이브

- CD/DVD 디스크

- 플로피 디스크

- 기존 9 추적 테이프

블록 장치 인터페이스의 유비쿼리티는 가상 블록 장치를 Red Hat Ceph Storage와 같은 대량 데이터 스토리지 시스템과 상호 작용하기에 적합한 후보로 만듭니다.

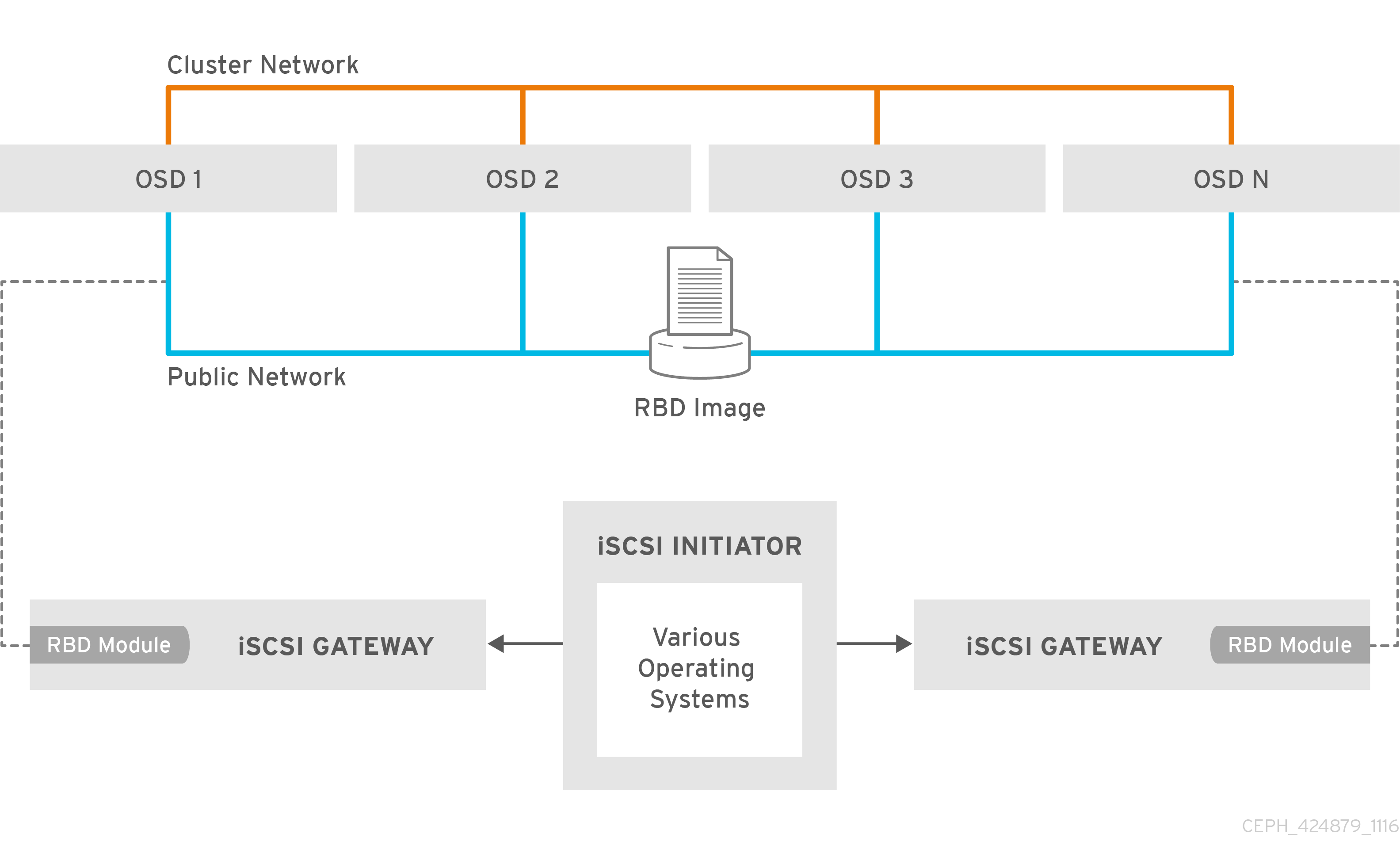

Ceph 블록 장치는 Ceph 스토리지 클러스터에서 여러 OSD(오브젝트 스토리지 장치)를 통해 제거된 씬 프로비저닝, 조정 가능 및 저장 데이터입니다. Ceph 블록 장치는 RADOS(Reliable Autonomic Distributed Object Store) 블록 장치(RBD)라고도 합니다. Ceph 블록 장치는 다음과 같은 RADOS 기능을 활용합니다.

- 스냅샷

- 복제

- 데이터 일관성

Ceph 블록 장치는 librbd 라이브러리를 사용하여 OSD와 상호 작용합니다.

Ceph 블록 장치는 libvirt 및 QEMU 유틸리티를 사용하여 Ceph 블록 장치와 통합되는 OpenStack과 같은 KVM(커널 가상 시스템) 및 클라우드 기반 컴퓨팅 시스템에 무한 확장성을 제공합니다. 동일한 스토리지 클러스터를 사용하여 Ceph Object Gateway 및 Ceph 블록 장치를 동시에 작동할 수 있습니다.

Ceph 블록 장치를 사용하려면 실행 중인 Ceph 스토리지 클러스터에 액세스할 수 있어야 합니다. Red Hat Ceph Storage 클러스터 설치에 대한 자세한 내용은 Red Hat Ceph Storage 설치 가이드를 참조하십시오.

2장. Ceph 블록 장치 명령

Ceph의 블록 장치 명령을 잘 알고 있는 스토리지 관리자는 Red Hat Ceph Storage 클러스터를 효과적으로 관리하는 데 도움이 됩니다. Ceph 블록 장치의 다양한 기능을 활성화 및 비활성화하고 함께 블록 장치 풀 및 이미지를 생성하고 관리할 수 있습니다.

2.1. 사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

2.2. 명령 도움말 표시

명령줄 인터페이스의 명령 및 하위 명령 온라인 도움말을 표시합니다.

h 옵션은 사용 가능한 모든 명령에 대한 도움말을 계속 표시합니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 클라이언트 노드에 대한 루트 수준 액세스.

절차

rbd help명령을 사용하여 특정rbd명령과 해당 하위 명령에 대한 도움말을 표시합니다.구문

rbd help COMMAND SUBCOMMAND

snap list명령에 대한 도움말을 표시하려면 다음을 수행합니다.[root@rbd-client ~]# rbd help snap list

2.3. 블록 장치 풀 생성

블록 장치 클라이언트를 사용하기 전에 rbd 의 풀이 활성화 및 초기화되었는지 확인합니다.

풀을 먼저 만들어야 해당 풀을 소스로 지정할 수 있습니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 클라이언트 노드에 대한 루트 수준 액세스.

절차

rbd풀을 만들려면 다음을 실행합니다.구문

ceph osd pool create POOL_NAME PG_NUM ceph osd pool application enable POOL_NAME rbd rbd pool init -p POOL_NAME

예제

[root@rbd-client ~]# ceph osd pool create example 128 [root@rbd-client ~]# ceph osd pool application enable example rbd [root@rbd-client ~]# rbd pool init -p example

추가 리소스

- 자세한 내용은 Red Hat Ceph Storage Storage Strategies Guide 의 풀 장을 참조하십시오.

2.4. 블록 장치 이미지 생성

블록 장치를 노드에 추가하기 전에 Ceph 스토리지 클러스터에 블록 장치를 만듭니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 클라이언트 노드에 대한 루트 수준 액세스.

절차

블록 장치 이미지를 생성하려면 다음 명령을 실행합니다.

구문

rbd create IMAGE_NAME --size MEGABYTES --pool POOL_NAME

예제

[root@rbd-client ~]# rbd create data --size 1024 --pool stack

이 예제에서는

stack이라는 풀에 정보를 저장하는data라는 1GB 이미지를 생성합니다.참고이미지를 생성하기 전에 풀이 있는지 확인합니다.

추가 리소스

- 자세 한 내용은 Red Hat Ceph Storage Block Device Guide 의 블록 장치 풀 생성 섹션을 참조하십시오.

2.5. 블록 장치 이미지 나열

블록 장치 이미지를 나열합니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 클라이언트 노드에 대한 루트 수준 액세스.

절차

rbd풀의 블록 장치를 나열하려면 다음 명령을 실행합니다(rbd는 기본 풀 이름임).[root@rbd-client ~]# rbd ls

특정 풀의 블록 장치를 나열하려면 다음 명령을 실행하되,

POOL_NAME을 풀 이름으로 바꿉니다.구문

rbd ls POOL_NAME예제

[root@rbd-client ~]# rbd ls swimmingpool

2.6. 블록 장치 이미지 정보 검색

블록 장치 이미지에 대한 정보를 검색합니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 클라이언트 노드에 대한 루트 수준 액세스.

절차

특정 이미지에서 정보를 검색하려면 다음 명령을 실행하고

IMAGE_NAME을 이미지 이름으로 바꿉니다.구문

rbd --image IMAGE_NAME info예제

[root@rbd-client ~]# rbd --image foo info

풀 내에서 이미지에서 정보를 검색하려면 다음 명령을 실행하고

IMAGE_NAME을 이미지 이름으로 바꾸고POOL_NAME을 풀 이름으로 바꿉니다.구문

rbd --image IMAGE_NAME -p POOL_NAME info

예제

[root@rbd-client ~]# rbd --image bar -p swimmingpool info

2.7. 블록 장치 이미지 크기 조정

Ceph 블록 장치 이미지는 씬 프로비저닝됩니다. 데이터 저장을 시작할 때까지 실제 스토리지를 사용하지 않습니다. 그러나 최대 용량은 --size 옵션으로 설정할 수 있습니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 클라이언트 노드에 대한 루트 수준 액세스.

절차

Ceph 블록 장치 이미지의 최대 크기를 늘리거나 줄입니다.

구문

[root@rbd-client ~]# rbd resize --image IMAGE_NAME --size SIZE

2.8. 블록 장치 이미지 제거

블록 장치 이미지를 제거합니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 클라이언트 노드에 대한 루트 수준 액세스.

절차

블록 장치를 제거하려면 다음을 실행하되

IMAGE_NAME을 삭제하려는 이미지 이름으로 교체합니다.구문

rbd rm IMAGE_NAME예제

[root@rbd-client ~]# rbd rm foo

풀에서 블록 장치를 제거하려면 다음을 실행하되

IMAGE_NAME을 삭제 및 제거할 이미지 이름으로 교체하여POOL_NAME을 풀 이름으로 교체합니다.구문

rbd rm IMAGE_NAME -p POOL_NAME

예제

[root@rbd-client ~]# rbd rm bar -p swimmingpool

2.9. 휴지통 명령을 사용하여 블록 장치 이미지 관리

RADOS 블록 장치(RBD) 이미지는 rbd 휴지통 명령을 사용하여 휴지통으로 이동할 수 있습니다.

이 명령은 다음과 같은 다양한 옵션을 제공합니다.

- 휴지통에서 이미지를 제거합니다.

- 휴지통의 이미지 나열.

- 휴지통에서 이미지 삭제 지연.

- 휴지통에서 이미지를 삭제합니다.

- 휴지통에서 이미지 복원

- 휴지통에서 이미지를 복원하고 이름을 바꿉니다.

- 휴지통에서 만료된 이미지 삭제.

- 휴지통에서 제거 예약.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 클라이언트 노드에 대한 루트 수준 액세스.

절차

이미지를 휴지통으로 이동합니다.

구문

rbd trash mv POOL_NAME/IMAGE_NAME

예제

[root@rbd-client ~]# rbd trash mv mypool/myimage

이미지가 휴지통에 있으면 고유한 이미지 ID가 할당됩니다.

참고나중에 휴지통 옵션을 사용해야 하는 경우 이미지를 지정하려면 이 이미지 ID가 필요합니다.

휴지통에 이미지를 나열합니다.

구문

rbd trash ls POOL_NAME예제

[root@rbd-client ~]# rbd trash ls mypool 1558a57fa43b rename_image

고유한 IMAGE_ID

1558a57fa43b는 모든 휴지통 옵션에 사용할 수 있습니다.이미지를 휴지통으로 이동하고 휴지통에서 이미지 삭제를 지연합니다.

구문

rbd trash mv POOL_NAME/IMAGE_NAME --expires-at "EXPIRATION_TIME"

EXPIRATION_TIME 은 초, 시간, 날짜, "HH:MM:SS" 또는 "tomorrow"의 시간일 수 있습니다.

예제

[root@rbd-client ~]# rbd trash mv mypool/myimage --expires-at "60 seconds"

이 예제에서

myimage는 휴지통으로 이동됩니다. 그러나 60 초까지 휴지통에서 삭제할 수 없습니다.휴지통에서 이미지를 복원합니다.

구문

rbd trash restore POOL_NAME/IMAGE_ID

예제

[root@rbd-client ~]# rbd trash restore mypool/14502ff9ee4d

휴지통에서 이미지를 삭제합니다.

구문

rbd trash rm POOL_NAME/IMAGE_ID [--force]

예제

[root@rbd-client ~]# rbd trash rm mypool/14502ff9ee4d Removing image: 100% complete...done.

이미지가 삭제 지연되면 만료까지 휴지통에서 삭제할 수 없습니다. 다음과 같은 오류 메시지가 표시됩니다.

예제

Deferment time has not expired, please use --force if you really want to remove the image Removing image: 0% complete...failed. 2021-12-02 06:37:49.573 7fb5d237a500 -1 librbd::api::Trash: remove: error: deferment time has not expired.

중요이미지가 휴지통에서 삭제되면 복원할 수 없습니다.

이미지의 이름을 변경하고 휴지통에서 복원합니다.

구문

rbd trash restore POOL_NAME/IMAGE_ID --image NEW_IMAGE_NAME

예제

[root@rbd-client ~]# rbd trash restore mypool/14502ff9ee4d --image test_image

휴지통에서 만료된 이미지를 제거합니다.

구문

rbd trash purge POOL_NAME예제

[root@rbd-client ~]# rbd trash purge mypool

이 예제에서는

mypool에서 휴지통을 가진 모든 이미지가 제거됩니다.

2.10. 이미지 기능 활성화 및 비활성화

기존 이미지에서 fast-diff,exclusive-lock,object-map 또는 저널링 과 같은 이미지 기능을 활성화하거나 비활성화할 수 있습니다.

딥 flatten 기능은 기존 이미지에서만 비활성화할 수 있지만 사용할 수는 없습니다. 딥 플랫 을 사용하려면 이미지를 생성할 때 활성화합니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 클라이언트 노드에 대한 루트 수준 액세스.

절차

기능을 활성화하려면 다음을 수행합니다.

구문

rbd feature enable POOL_NAME/IMAGE_NAME FEATURE_NAME

데이터풀의image1이미지에서배타적 잠금기능을 활성화하려면 다음을 수행합니다.예제

[root@rbd-client ~]# rbd feature enable data/image1 exclusive-lock

중요fast-diff및object-map기능을 활성화하면 오브젝트 맵을 다시 빌드합니다.+ .Syntax

rbd object-map rebuild POOL_NAME/IMAGE_NAME

기능을 비활성화하려면 다음을 수행합니다.

구문

rbd feature disable POOL_NAME/IMAGE_NAME FEATURE_NAME

데이터풀의image2이미지에서fast-diff기능을 비활성화하려면 다음을 수행합니다.예제

[root@rbd-client ~]# rbd feature disable data/image2 fast-diff

2.11. 이미지 메타데이터 작업

Ceph는 사용자 지정 이미지 메타데이터를 키-값 쌍으로 추가할 수 있도록 지원합니다. 쌍에는 엄격한 형식이 없습니다.

또한 메타데이터를 사용하면 특정 이미지에 대해 RADOS Block Device(RBD) 구성 매개변수를 설정할 수 있습니다.

rbd image-meta 명령을 사용하여 메타데이터로 작업합니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 클라이언트 노드에 대한 루트 수준 액세스.

절차

새 메타데이터 키-값 쌍을 설정하려면 다음을 수행합니다.

구문

rbd image-meta set POOL_NAME/IMAGE_NAME KEY VALUE

예제

[root@rbd-client ~]# rbd image-meta set data/dataset last_update 2016-06-06

이 예에서는 데이터 풀의

데이터 세트 이미지에.last_update키를2016-06-06값으로 설정합니다메타데이터 키-값 쌍을 제거하려면 다음을 수행합니다.

구문

rbd image-meta remove POOL_NAME/IMAGE_NAME KEY

예제

[root@rbd-client ~]# rbd image-meta remove data/dataset last_update

이 예제에서는 데이터 풀의

데이터 세트이미지에서last_update키-값 쌍을 제거합니다.키 값을 보려면 다음을 수행합니다.

구문

rbd image-meta get POOL_NAME/IMAGE_NAME KEY

예제

[root@rbd-client ~]# rbd image-meta get data/dataset last_update

이 예제에서는

last_update키의 값을 봅니다.이미지의 모든 메타데이터를 표시하려면 다음을 수행합니다.

구문

rbd image-meta list POOL_NAME/IMAGE_NAME

예제

[root@rbd-client ~]# rbd data/dataset image-meta list

이 예에서는 데이터 풀의

데이터 세트 이미지에 대한 메타데이터 세트를 나열합니다.Ceph 구성 파일에 특정 이미지의 RBD 이미지 구성 설정을 재정의하려면 다음을 수행합니다.

구문

rbd config image set POOL_NAME/IMAGE_NAME PARAMETER VALUE

예제

[root@rbd-client ~]# rbd config image set data/dataset rbd_cache false

이 예제에서는 데이터 풀에서

데이터 세트이미지에 대한 RBD 캐시를 비활성화합니다.

추가 리소스

- 가능한 구성 옵션 목록은 Red Hat Ceph Storage Block Device Guide 의 블록 장치 일반 옵션 섹션을 참조하십시오.

2.12. 풀 간 이미지 이동

RADOS Block Device(RBD) 이미지를 동일한 클러스터 내의 여러 풀 간에 이동할 수 있습니다. 마이그레이션은 복제된 풀, 삭제 코드된 풀 또는 복제된 풀과 삭제 코드된 풀 간에 마이그레이션할 수 있습니다.

이 프로세스 중에 소스 이미지가 모든 스냅샷 기록으로 대상 이미지에 복사되고 선택적으로 소스 이미지의 상위에 대한 링크가 있어 스파스성을 보존할 수 있습니다. 소스 이미지는 읽기 전용이며 대상 이미지는 쓸 수 있습니다. 마이그레이션이 진행 중인 동안 대상 이미지가 소스 이미지에 연결됩니다.

새 대상 이미지가 사용 중인 동안 이 프로세스를 백그라운드에서 안전하게 실행할 수 있습니다. 그러나 준비 단계를 수행하기 전에 대상 이미지를 사용하는 모든 클라이언트를 중지하여 이미지를 사용하는 클라이언트가 새 대상 이미지를 가리키도록 업데이트되었는지 확인합니다.

krbd 커널 모듈은 현재 실시간 마이그레이션을 지원하지 않습니다.

사전 요구 사항

- 소스 이미지를 사용하는 모든 클라이언트를 중지합니다.

- 클라이언트 노드에 대한 루트 수준 액세스.

절차

소스 및 대상 이미지를 상호 연결하는 새 대상 이미지를 생성하여 마이그레이션을 준비합니다.

구문

rbd migration prepare SOURCE_IMAGE TARGET_IMAGE

교체:

- 이동할 이미지 이름이 SOURCE_IMAGE 입니다. POOL/IMAGE_NAME 형식을 사용합니다.

- 새 이미지 이름으로 TARGET_IMAGE. POOL/IMAGE_NAME 형식을 사용합니다.

예제

[root@rbd-client ~]# rbd migration prepare data/source stack/target

새 대상 이미지의 상태를 확인합니다.

준비됨:구문

rbd status TARGET_IMAGE예제

[root@rbd-client ~]# rbd status stack/target Watchers: none Migration: source: data/source (5e2cba2f62e) destination: stack/target (5e2ed95ed806) state: prepared- 선택적으로 새 대상 이미지 이름을 사용하여 클라이언트를 다시 시작합니다.

대상 이미지에 소스 이미지를 복사합니다.

구문

rbd migration execute TARGET_IMAGE예제

[root@rbd-client ~]# rbd migration execute stack/target

마이그레이션이 완료되었는지 확인합니다.

예제

[root@rbd-client ~]# rbd status stack/target Watchers: watcher=1.2.3.4:0/3695551461 client.123 cookie=123 Migration: source: data/source (5e2cba2f62e) destination: stack/target (5e2ed95ed806) state: executed소스 이미지와 대상 이미지 간의 교차 링크를 제거하여 마이그레이션을 커밋하고 소스 이미지도 제거됩니다.

구문

rbd migration commit TARGET_IMAGE예제

[root@rbd-client ~]# rbd migration commit stack/target

소스 이미지가 하나 이상의 복제본의 상위인 경우 복제 이미지가 사용되지 않도록 한 후

--force옵션을 사용합니다.예제

[root@rbd-client ~]# rbd migration commit stack/target --force

- 준비 단계 후에 클라이언트를 다시 시작하지 않은 경우 새 대상 이미지 이름을 사용하여 클라이언트를 다시 시작합니다.

2.13. rbdmap 서비스

systemd 장치 파일 rbdmap.service 는 ceph-common 패키지에 포함되어 있습니다. rbdmap.service 장치는 rbdmap 쉘 스크립트를 실행합니다.

이 스크립트는 하나 이상의 RBD 이미지에 대해 RADOS 블록 장치(RBD) 매핑 및 매핑 해제를 자동화합니다. 이 스크립트는 언제든지 수동으로 실행할 수 있지만 일반적인 사용 사례는 부팅 시 RBD 이미지를 자동으로 마운트하고 종료 시 마운트 해제하는 것입니다. 이 스크립트는 RBD 이미지를 마운트하기 위해 매핑 또는 매핑 해제 할 수 있는 단일 인수를 사용합니다. 이 스크립트는 구성 파일을 구문 분석합니다. 기본값은 /etc/ceph/rbdmap 이지만 RBDMAPFILE 이라는 환경 변수를 사용하여 재정의할 수 있습니다. 구성 파일의 각 행은 RBD 이미지에 해당합니다.

구성 파일 형식의 형식은 다음과 같습니다.

IMAGE_SPEC RBD_OPTS

여기서 IMAGE_SPEC 는 POOL_NAME / IMAGE_NAME 또는 POOL_NAME 만 지정합니다. 이 경우 POOL_NAME 은 rbd 로 설정됩니다. RBD_OPTS 는 기본 rbd 맵 명령에 전달할 옵션 목록입니다. 이러한 매개변수와 해당 값은 쉼표로 구분된 문자열로 지정해야 합니다.

OPT1=VAL1,OPT2=VAL2,…,OPT_N=VAL_N

이로 인해 스크립트에서 다음과 같은 rbd 맵 명령을 발행합니다.

rbd map POOLNAME/IMAGE_NAME --OPT1 VAL1 --OPT2 VAL2

쉼표 또는 같음 표시가 포함된 옵션과 값의 경우 간단한 apostrophe를 사용하여 교체하지 않도록 할 수 있습니다.

성공하면 rbd 맵 작업은 이미지를 /dev/rbdX 장치에 매핑합니다. 여기서 udev 규칙이 트리거되면 친숙한 장치 이름 symlink(예: /dev/rbd/ POOL_NAME /POOL_NAME/ POOL_NAME )가 생성되어 실제 매핑된 장치를 가리킵니다. 마운트 또는 마운트 해제하려면 친숙한 장치 이름에 /etc/fstab 파일에 해당 항목이 있어야 합니다. RBD 이미지에 대한 /etc/fstab 항목을 작성할 때 noauto 또는 nofail 마운트 옵션을 지정하는 것이 좋습니다. 이렇게 하면 장치가 발생하기 전에 init 시스템이 장치를 너무 일찍 마운트하지 않습니다.

추가 리소스

-

사용 가능한 옵션의 전체 목록은

rbdmanpage를 참조하십시오.

2.14. rbdmap 서비스 구성

부팅 시 RADOS 블록 장치(RBD)를 자동으로 매핑 및 마운트 해제 또는 마운트 해제하거나 각각 종료하십시오.

사전 요구 사항

- 마운트를 수행하는 노드에 대한 루트 수준 액세스.

-

ceph-common패키지 설치.

절차

-

/etc/ceph/rbdmap구성 파일을 편집하려면 을 엽니다. 구성 파일에 RBD 이미지 또는 이미지를 추가합니다.

예제

foo/bar1 id=admin,keyring=/etc/ceph/ceph.client.admin.keyring foo/bar2 id=admin,keyring=/etc/ceph/ceph.client.admin.keyring,options='lock_on_read,queue_depth=1024'

- 구성 파일에 변경 사항을 저장합니다.

RBD 매핑 서비스를 활성화합니다.

예제

[root@client ~]# systemctl enable rbdmap.service

추가 리소스

-

RBD 시스템 서비스에 대한 자세한 내용은 Red Hat Ceph Storage Block Device Guide 의

rbdmap서비스 섹션을 참조하십시오.

2.15. 명령줄 인터페이스를 사용하여 Ceph 블록 장치의 성능 모니터링

Red Hat Ceph Storage 4.1부터 성능 지표 수집 프레임워크는 Ceph OSD 및 Manager 구성 요소에 통합되어 있습니다. 이 프레임워크는 다른 Ceph 블록 장치 성능 모니터링 솔루션이 구축된 기본 제공 방법을 제공합니다.

새 Ceph Manager 모듈rbd_support 는 활성화된 경우 성능 지표를 집계합니다. rbd 명령에는 iotop 및 iostat 의 두 가지 새로운 동작이 있습니다.

이러한 작업의 초기 사용은 데이터 필드를 채우는 데 약 30초가 걸릴 수 있습니다.

사전 요구 사항

- Ceph 모니터 노드에 대한 사용자 수준 액세스.

절차

rbd_supportCeph Manager 모듈을 활성화합니다.예제

[user@mon ~]$ ceph mgr module enable rbd_support

"iotop" 유형의 이미지를 표시하려면 다음을 수행합니다.

예제

[user@mon ~]$ rbd perf image iotop

참고오른쪽 및 왼쪽 화살표 키를 사용하여 ops, read-ops, write-bytes, write-latency 및 read-latency 열을 동적으로 정렬할 수 있습니다.

이미지의 "iostat" 스타일을 표시하려면 다음을 수행합니다.

예제

[user@mon ~]$ rbd perf image iostat

참고이 명령의 출력은 JSON 또는 XML 형식일 수 있으며 다른 명령줄 툴을 사용하여 정렬할 수 있습니다.

2.16. 추가 리소스

-

매핑 및 매핑되지 않은 블록 장치에 대한 자세한 내용은 3장.

rbd커널 모듈 을 참조하십시오.

3장. rbd 커널 모듈

스토리지 관리자는 rbd 커널 모듈을 통해 Ceph 블록 장치에 액세스할 수 있습니다. 블록 장치를 매핑 및 매핑 해제하고 해당 매핑을 표시할 수 있습니다. 또한 rbd kernel 모듈을 통해 이미지 목록을 가져올 수 있습니다.

RHEL(Red Hat Enterprise Linux) 이외의 Linux 배포판의 커널 클라이언트는 허용되지만 지원되지 않습니다. 이러한 커널 클라이언트를 사용할 때 스토리지 클러스터에서 문제가 발견되면 Red Hat은 이러한 문제를 해결하지만 근본 원인이 커널 클라이언트측에 있는 경우 소프트웨어 벤더가 해결해야 합니다.

3.1. 사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

3.2. Ceph 블록 장치 생성 및 Linux 커널 모듈 클라이언트에서 사용

스토리지 관리자는 Red Hat Ceph Storage 대시보드에서 Linux 커널 모듈 클라이언트에 대한 Ceph 블록 장치를 생성할 수 있습니다. 시스템 관리자는 명령줄을 사용하여 Linux 클라이언트에서 해당 블록 장치를 매핑하고 파티션, 포맷, 마운트할 수 있습니다. 이렇게 하면 파일을 읽고 쓸 수 있습니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- Red Hat Enterprise Linux 클라이언트.

3.2.1. 대시보드를 사용하여 Linux 커널 모듈 클라이언트용 Ceph 블록 장치 생성

필요한 기능만 활성화하여 대시보드 웹 인터페이스를 사용하여 Linux 커널 모듈 클라이언트를 위해 Ceph Block Device를 생성할 수 있습니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

절차

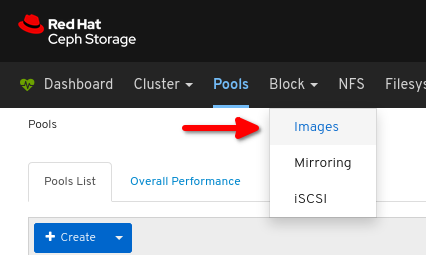

- 대시보드에 로그인합니다.

네비게이션 바에서 Pools (풀)를 클릭합니다.

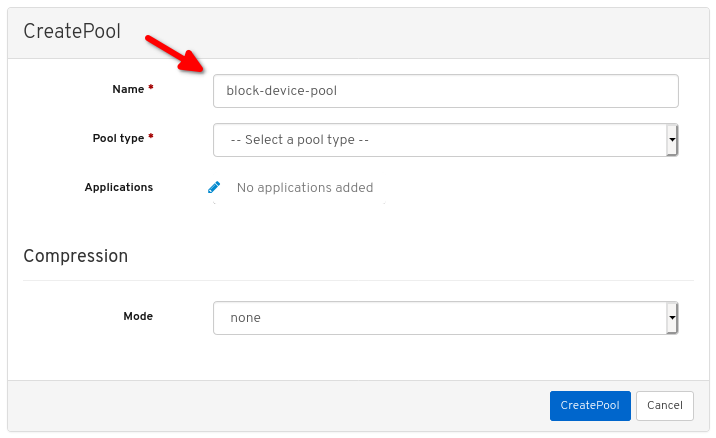

생성 버튼을 클릭합니다.

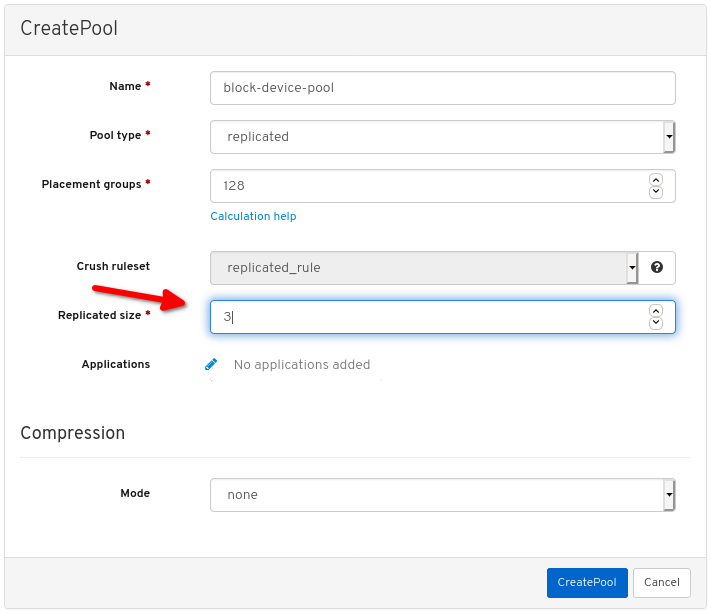

대화 상자에서 이름을 설정합니다.

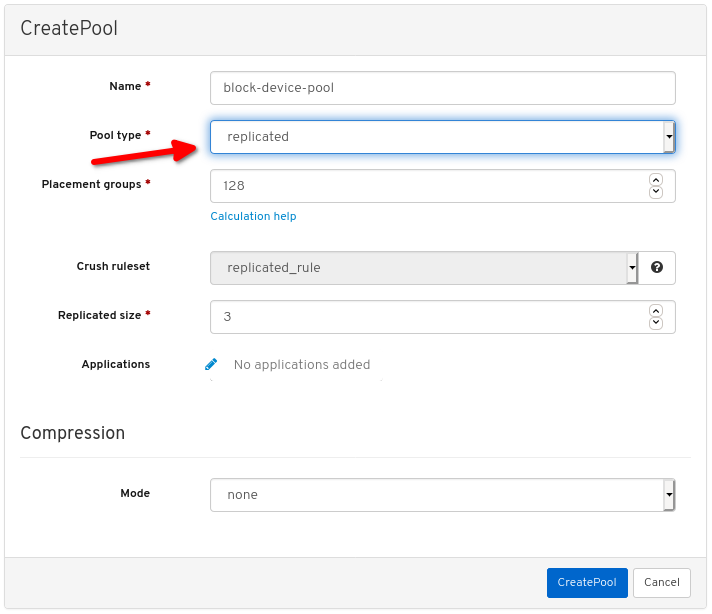

풀 유형을 replicated로 설정합니다.

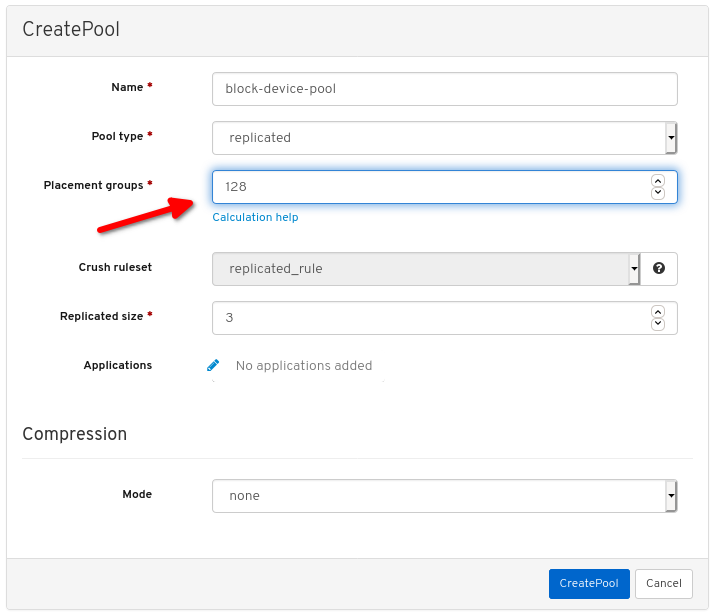

PG(배치 그룹) 번호를 설정합니다.

PG 번호 선택에 대한 지원을 받으려면 PG 계산기 를 사용하십시오. 확실하지 않은 경우 Red Hat 기술 지원에 문의하십시오.

복제된 크기를 설정합니다.

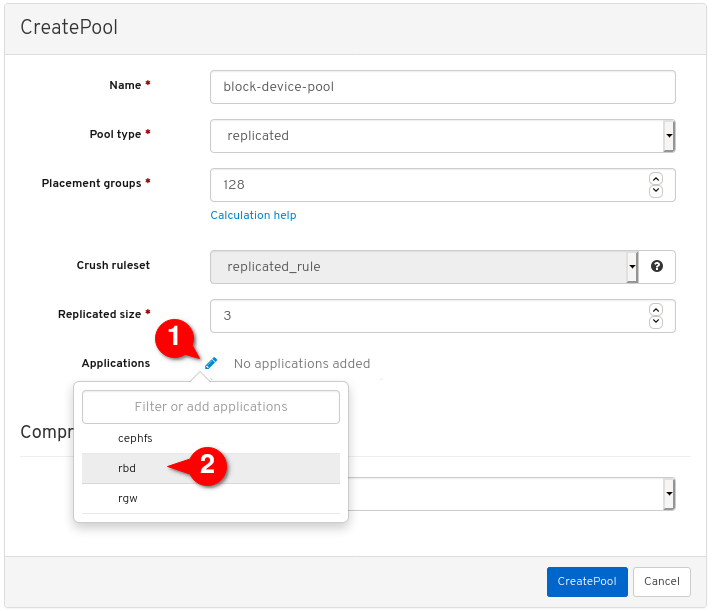

rbd애플리케이션을 활성화합니다.

풀 생성을 클릭합니다.

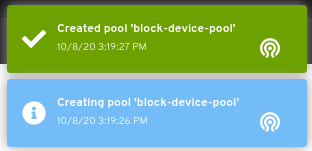

풀이 성공적으로 생성되었음을 나타내는 알림을 확인합니다.

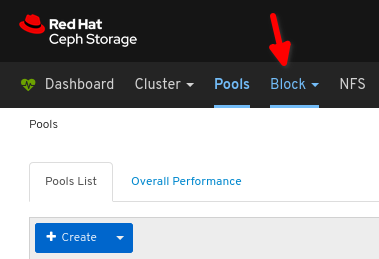

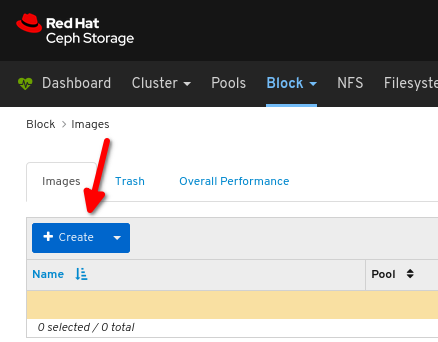

Block 을 클릭합니다.

이미지 를 클릭합니다.

생성 을 클릭합니다.

원하는 이미지 이름,

원하는 이미지 이름,

풀을 이전에 생성한 풀 로 설정하고

풀을 이전에 생성한 풀 로 설정하고

에서 원하는 이미지 크기를 설정하며,

에서 원하는 이미지 크기를 설정하며,

계층화 및 제외 잠금 이 유일한 활성화된 기능인지 확인합니다.

계층화 및 제외 잠금 이 유일한 활성화된 기능인지 확인합니다.

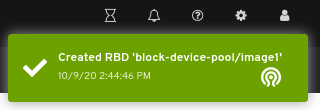

CreateRBD:를 클릭합니다.

이미지가 성공적으로 생성되었음을 나타내는 알림을 확인합니다.

추가 리소스

- 자세 한 내용은 명령줄을 사용하여 Linux에서 Ceph 블록 장치 맵 및 마운트를 참조하십시오.

- 자세한 내용은 대시보드 가이드 를 참조하십시오.

3.2.2. 명령줄을 사용하여 Linux에서 Ceph 블록 장치 매핑 및 마운트

Linux rbd 커널 모듈을 사용하여 Red Hat Enterprise Linux 클라이언트에서 Ceph 블록 장치를 매핑할 수 있습니다. 매핑 후 파티션, 포맷 및 마운트할 수 있으므로 파일을 쓸 수 있습니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- Linux 커널 모듈 클라이언트용 Ceph 블록 장치가 생성되었습니다.

- Red Hat Enterprise Linux 클라이언트.

절차

Red Hat Enterprise Linux 클라이언트 노드에서 Red Hat Ceph Storage 4 툴 리포지토리를 활성화합니다.

Red Hat Enterprise Linux 7

[root@client1 ~]# subscription-manager repos --enable=rhel-7-server-rhceph-4-tools-rpms

Red Hat Enterprise Linux 8

[root@client1 ~]# subscription-manager repos --enable=rhceph-4-tools-for-rhel-8-x86_64-rpms

ceph-commonRPM 패키지를 설치합니다.Red Hat Enterprise Linux 7

[root@client1 ~]# yum install ceph-common

Red Hat Enterprise Linux 8

[root@client1 ~]# dnf install ceph-common

모니터 노드에서 클라이언트 노드로 Ceph 구성 파일을 복사합니다.

scp root@MONITOR_NODE:/etc/ceph/ceph.conf /etc/ceph/ceph.conf예제

[root@client1 ~]# scp root@cluster1-node2:/etc/ceph/ceph.conf /etc/ceph/ceph.conf root@192.168.0.32's password: ceph.conf 100% 497 724.9KB/s 00:00

모니터 노드에서 클라이언트 노드로 키 파일을 복사합니다.

scp root@MONITOR_NODE:/etc/ceph/ceph.client.admin.keyring /etc/ceph/ceph.client.admin.keyring예제

[root@client1 ~]# scp root@cluster1-node2:/etc/ceph/ceph.client.admin.keyring /etc/ceph/ceph.client.admin.keyring root@192.168.0.32's password: ceph.client.admin.keyring 100% 151 265.0KB/s 00:00

이미지를 매핑합니다.

rbd map --pool POOL_NAME IMAGE_NAME --id admin

예제

[root@client1 ~]# rbd map --pool block-device-pool image1 --id admin /dev/rbd0 [root@client1 ~]#

블록 장치에 파티션 테이블을 만듭니다.

parted /dev/MAPPED_BLOCK_DEVICE mklabel msdos예제

[root@client1 ~]# parted /dev/rbd0 mklabel msdos Information: You may need to update /etc/fstab.

XFS 파일 시스템의 파티션을 생성합니다.

parted /dev/MAPPED_BLOCK_DEVICE mkpart primary xfs 0% 100%예제

[root@client1 ~]# parted /dev/rbd0 mkpart primary xfs 0% 100% Information: You may need to update /etc/fstab.

파티션을 포맷합니다.

mkfs.xfs /dev/MAPPED_BLOCK_DEVICE_WITH_PARTITION_NUMBER예제

[root@client1 ~]# mkfs.xfs /dev/rbd0p1 meta-data=/dev/rbd0p1 isize=512 agcount=16, agsize=163824 blks = sectsz=512 attr=2, projid32bit=1 = crc=1 finobt=1, sparse=1, rmapbt=0 = reflink=1 data = bsize=4096 blocks=2621184, imaxpct=25 = sunit=16 swidth=16 blks naming =version 2 bsize=4096 ascii-ci=0, ftype=1 log =internal log bsize=4096 blocks=2560, version=2 = sectsz=512 sunit=16 blks, lazy-count=1 realtime =none extsz=4096 blocks=0, rtextents=0에 새 파일 시스템을 마운트할 디렉토리를 생성합니다.

mkdir PATH_TO_DIRECTORY예제

[root@client1 ~]# mkdir /mnt/ceph

파일 시스템을 마운트합니다.

mount /dev/MAPPED_BLOCK_DEVICE_WITH_PARTITION_NUMBER PATH_TO_DIRECTORY

예제

[root@client1 ~]# mount /dev/rbd0p1 /mnt/ceph/

파일 시스템이 마운트되어 올바른 크기를 표시하는지 확인합니다.

df -h PATH_TO_DIRECTORY예제

[root@client1 ~]# df -h /mnt/ceph/ Filesystem Size Used Avail Use% Mounted on /dev/rbd0p1 10G 105M 9.9G 2% /mnt/ceph

추가 리소스

- 자세 한 내용은 대시보드를 사용하여 Linux 커널 모듈 클라이언트의 Ceph 블록 장치 만들기를 참조하십시오.

- 자세한 내용은 Managing file systems for Red Hat Enterprise Linux 8을 참조하십시오.

- 자세한 내용은 Red Hat Enterprise Linux 7의 스토리지 관리 가이드 를 참조하십시오.

3.3. 이미지 목록 가져오기

Ceph 블록 장치 이미지 목록을 가져옵니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 노드에 대한 루트 수준 액세스.

절차

블록 장치 이미지를 마운트하려면 먼저 이미지 목록을 반환합니다.

[root@rbd-client ~]# rbd list

3.4. 블록 장치 매핑

rbd 를 사용하여 이미지 이름을 커널 모듈에 매핑합니다. 이미지 이름, 풀 이름 및 사용자 이름을 지정해야 합니다. RBD 커널 모듈이 아직 로드되지 않은 경우 RBD 커널 모듈이 로드됩니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 노드에 대한 루트 수준 액세스.

절차

커널 모듈에 이미지 이름을 매핑합니다.

구문

rbd device map POOL_NAME/IMAGE_NAME --id USER_NAME

예제

[root@rbd-client ~]# rbd device map rbd/myimage --id admin

인증 키 또는 시크릿이 포함된 파일을 통해

cephx인증을 사용할 때 보안을 지정합니다.구문

[root@rbd-client ~]# rbd device map POOL_NAME/IMAGE_NAME --id USER_NAME --keyring PATH_TO_KEYRING

또는

[root@rbd-client ~]# rbd device map POOL_NAME/IMAGE_NAME --id USER_NAME --keyfile PATH_TO_FILE

3.5. 매핑된 블록 장치 표시

rbd 명령을 사용하여 커널 모듈에 매핑되는 블록 장치 이미지를 표시할 수 있습니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 노드에 대한 루트 수준 액세스.

절차

매핑된 블록 장치를 표시합니다.

[root@rbd-client ~]# rbd device list

3.6. 블록 장치 매핑 해제

unmap 옵션을 사용하고 장치 이름을 제공하여 rbd 명령으로 블록 장치 이미지를 매핑할 수 있습니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 노드에 대한 루트 수준 액세스.

절차

블록 장치 이미지를 매핑 해제합니다.

구문

rbd device unmap /dev/rbd/POOL_NAME/IMAGE_NAME

예제

[root@rbd-client ~]# rbd device unmap /dev/rbd/rbd/foo

3.7. 동일한 풀 내에서 격리된 네임스페이스 내에서 이미지 분리

OpenStack 또는 OpenShift Container Storage와 같은 고급 시스템 없이 Ceph 블록 장치를 직접 사용하는 경우 특정 블록 장치 이미지에 대한 사용자 액세스를 제한할 수 없었습니다. CephX 기능과 함께 사용자는 특정 풀 네임스페이스로 제한하여 이미지에 대한 액세스를 제한할 수 있습니다.

새 수준의 ID인 RADOS 네임스페이스를 사용하여 오브젝트를 식별하고 풀 내에서 rados 클라이언트 간의 격리를 제공할 수 있습니다. 예를 들어 클라이언트는 해당하는 네임스페이스에 대한 전체 권한만 가질 수 있습니다. 이렇게 하면 테넌트마다 다른 RADOS 클라이언트를 사용할 수 있습니다. 이는 특히 다양한 테넌트가 자체 블록 장치 이미지에 액세스하는 블록 장치에 유용합니다.

동일한 풀 내에서 격리된 네임스페이스 내에서 블록 장치 이미지를 분리할 수 있습니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 모든 커널을 4x로 업그레이드하고 모든 클라이언트에서 librbd 및 librados로 업그레이드합니다.

- 모니터 및 클라이언트 노드에 대한 루트 수준 액세스.

절차

rbd풀을 만듭니다.구문

ceph osd pool create POOL_NAME PG_NUM

예제

[root@mon ~]# ceph osd pool create mypool 100 pool 'mypool' created

rbd풀을 RBD 애플리케이션과 연결합니다.구문

ceph osd pool application enable POOL_NAME rbd예제

[root@mon ~]# ceph osd pool application enable mypool rbd enabled application 'rbd' on pool 'mypool'

RBD 애플리케이션으로 풀을 초기화합니다.

구문

rbd pool init -p POOL_NAME예제

[root@mon ~]# rbd pool init -p mypool

두 개의 네임스페이스를 생성합니다.

구문

rbd namespace create --namespace NAMESPACE예제

[root@mon ~]# rbd namespace create --namespace namespace1 [root@mon ~]# rbd namespace create --namespace namespace2 [root@mon ~]# rbd namespace ls --format=json [{"name":"namespace2"},{"name":"namespace1"}]두 사용자의 네임스페이스에 대한 액세스 권한을 제공합니다.

구문

ceph auth get-or-create client.USER_NAME mon 'profile rbd' osd 'profile rbd pool=rbd namespace=NAMESPACE' -o /etc/ceph/client.USER_NAME.keyring

예제

[root@mon ~]# ceph auth get-or-create client.testuser mon 'profile rbd' osd 'profile rbd pool=rbd namespace=namespace1' -o /etc/ceph/client.testuser.keyring [root@mon ~]# ceph auth get-or-create client.newuser mon 'profile rbd' osd 'profile rbd pool=rbd namespace=namespace2' -o /etc/ceph/client.newuser.keyring

클라이언트의 키를 가져옵니다.

구문

ceph auth get client.USER_NAME예제

[root@mon ~]# ceph auth get client.testuser [client.testuser] key = AQDMp61hBf5UKRAAgjQ2In0Z3uwAase7mrlKnQ== caps mon = "profile rbd" caps osd = "profile rbd pool=rbd namespace=namespace1" exported keyring for client.testuser [root@mon ~]# ceph auth get client.newuser [client.newuser] key = AQDfp61hVfLFHRAA7D80ogmZl80ROY+AUG4A+Q== caps mon = "profile rbd" caps osd = "profile rbd pool=rbd namespace=namespace2" exported keyring for client.newuser

블록 장치 이미지를 생성하고 풀 내에서 사전 정의된 네임스페이스를 사용합니다.

구문

rbd create --namespace NAMESPACE IMAGE_NAME --size SIZE_IN_GB

예제

[root@mon ~]# rbd create --namespace namespace1 image01 --size 1G [root@mon ~]# rbd create --namespace namespace2 image02 --size 1G

선택 사항: 네임스페이스 및 관련 이미지의 세부 정보를 가져옵니다.

구문

rbd --namespace NAMESPACE ls --long예제

[root@mon ~]# rbd --namespace namespace1 ls --long NAME SIZE PARENT FMT PROT LOCK image01 1 GiB 2 [root@mon ~]# rbd --namespace namespace2 ls --long NAME SIZE PARENT FMT PROT LOCK image02 1 GiB 2

Ceph Monitor 노드의 Ceph 구성 파일을 클라이언트 노드로 복사합니다.

scp /etc/ceph/ceph.conf root@CLIENT_NODE:/etc/ceph/예제

[root@mon ~]# scp /etc/ceph/ceph.conf root@host02:/etc/ceph/ root@host02's password: ceph.conf 100% 497 724.9KB/s 00:00

Ceph Monitor 노드에서 클라이언트 노드로 관리자 인증 키를 복사합니다.

구문

scp /etc/ceph/ceph.client.admin.keyring root@CLIENT_NODE:/etc/ceph예제

[root@mon ~]# scp /etc/ceph/ceph.client.admin.keyring root@host02:/etc/ceph/ root@host02's password: ceph.client.admin.keyring 100% 151 265.0KB/s 00:00

Ceph 모니터 노드에서 클라이언트 노드로 사용자의 인증 키를 복사합니다.

구문

scp /etc/ceph/ceph.client.USER_NAME.keyring root@CLIENT_NODE:/etc/ceph/

예제

[root@mon ~]# scp /etc/ceph/client.newuser.keyring root@host02:/etc/ceph/ [root@mon ~]# scp /etc/ceph/client.testuser.keyring root@host02:/etc/ceph/

블록 장치 이미지를 매핑합니다.

구문

rbd map --name NAMESPACE IMAGE_NAME -n client.USER_NAME --keyring /etc/ceph/client.USER_NAME.keyring

예제

[root@mon ~]# rbd map --namespace namespace1 image01 -n client.testuser --keyring=/etc/ceph/client.testuser.keyring /dev/rbd0 [root@mon ~]# rbd map --namespace namespace2 image02 -n client.newuser --keyring=/etc/ceph/client.newuser.keyring /dev/rbd1

동일한 풀에 있는 다른 네임스페이스의 사용자에게 액세스할 수 없습니다.

예제

[root@mon ~]# rbd map --namespace namespace2 image02 -n client.testuser --keyring=/etc/ceph/client.testuser.keyring rbd: warning: image already mapped as /dev/rbd1 rbd: sysfs write failed rbd: error asserting namespace: (1) Operation not permitted In some cases useful info is found in syslog - try "dmesg | tail". 2021-12-06 02:49:08.106 7f8d4fde2500 -1 librbd::api::Namespace: exists: error asserting namespace: (1) Operation not permitted rbd: map failed: (1) Operation not permitted [root@mon ~]# rbd map --namespace namespace1 image01 -n client.newuser --keyring=/etc/ceph/client.newuser.keyring rbd: warning: image already mapped as /dev/rbd0 rbd: sysfs write failed rbd: error asserting namespace: (1) Operation not permitted In some cases useful info is found in syslog - try "dmesg | tail". 2021-12-03 12:16:24.011 7fcad776a040 -1 librbd::api::Namespace: exists: error asserting namespace: (1) Operation not permitted rbd: map failed: (1) Operation not permitted

장치를 확인합니다.

예제

[root@mon ~]# rbd showmapped id pool namespace image snap device 0 rbd namespace1 image01 - /dev/rbd0 1 rbd namespace2 image02 - /dev/rbd1

4장. 스냅샷 관리

Ceph 스냅샷 기능에 익숙한 스토리지 관리자는 Red Hat Ceph Storage 클러스터에 저장된 이미지의 스냅샷 및 복제본을 관리하는 데 도움이 됩니다.

4.1. 사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

4.2. Ceph 블록 장치 스냅샷

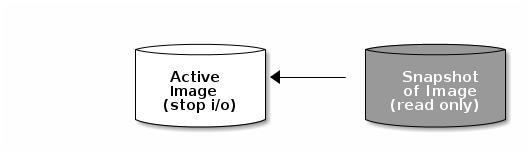

스냅샷은 특정 시점의 이미지 상태에 대한 읽기 전용 사본입니다. Ceph 블록 장치의 고급 기능 중 하나는 이미지의 스냅샷을 작성하여 이미지 상태 기록을 유지할 수 있다는 것입니다. 또한 Ceph에서는 스냅샷 계층 지정을 지원하므로 이미지를 빠르고 쉽게 복제할 수 있습니다(예: 가상 시스템 이미지). Ceph는 QEMU,libvirt, OpenStack 및 CloudStack을 포함하여 rbd 명령과 더 높은 수준의 인터페이스를 사용하여 블록 장치 스냅샷을 지원합니다.

I/O 가 발생하는 동안 스냅샷을 만든 경우 스냅샷에 이미지의 정확한 또는 최신 데이터를 얻지 못할 수 있으며 스냅샷을 마운트하기 위해 스냅샷을 새 이미지에 복제해야 할 수 있습니다. Red Hat은 이미지 스냅샷을 생성하기 전에 I/O 를 중지하도록 권장합니다. 이미지에 파일 시스템이 포함된 경우 스냅샷을 생성하기 전에 파일 시스템이 일관된 상태여야 합니다. I/O 를 중지하려면 fsfreeze 명령을 사용할 수 있습니다. 가상 머신의 경우 qemu-guest-agent 를 사용하여 스냅샷을 생성할 때 파일 시스템을 자동으로 정지할 수 있습니다.

추가 리소스

-

자세한 내용은

fsfreeze(8)매뉴얼 페이지를 참조하십시오.

4.3. Ceph 사용자 및 인증 키

cephx 가 활성화된 경우 사용자 이름 또는 ID와 사용자의 해당 키가 포함된 인증 키의 경로를 지정해야 합니다.

cephx 는 기본적으로 활성화되어 있습니다.

CEPH_ARGS 환경 변수를 추가하여 다음 매개변수의 재입력을 방지할 수 있습니다.

구문

rbd --id USER_ID --keyring=/path/to/secret [commands] rbd --name USERNAME --keyring=/path/to/secret [commands]

예제

[root@rbd-client ~]# rbd --id admin --keyring=/etc/ceph/ceph.keyring [commands] [root@rbd-client ~]# rbd --name client.admin --keyring=/etc/ceph/ceph.keyring [commands]

CEPH_ARGS 환경 변수에 사용자와 시크릿을 추가하여 매번 입력할 필요가 없습니다.

4.4. 블록 장치 스냅샷 생성

Ceph 블록 장치의 스냅샷을 만듭니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 노드에 대한 루트 수준 액세스.

절차

snap create옵션, 풀 이름 및 이미지 이름을 지정합니다.구문

rbd --pool POOL_NAME snap create --snap SNAP_NAME IMAGE_NAME rbd snap create POOL_NAME/IMAGE_NAME@SNAP_NAME

예제

[root@rbd-client ~]# rbd --pool rbd snap create --snap snapname foo [root@rbd-client ~]# rbd snap create rbd/foo@snapname

4.5. 블록 장치 스냅샷 나열

블록 장치 스냅샷을 나열합니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 노드에 대한 루트 수준 액세스.

절차

풀 이름과 이미지 이름을 지정합니다.

구문

rbd --pool POOL_NAME snap ls IMAGE_NAME rbd snap ls POOL_NAME/IMAGE_NAME

예제

[root@rbd-client ~]# rbd --pool rbd snap ls foo [root@rbd-client ~]# rbd snap ls rbd/foo

4.6. 블록 장치 스냅샷 롤백

블록 장치 스냅샷을 롤백합니다.

이미지를 스냅샷으로 롤백한다는 것은 스냅샷의 데이터로 현재 버전의 이미지를 덮어쓰는 것을 의미합니다. 롤백을 실행하는 데 걸리는 시간은 이미지 크기에 따라 증가합니다. 이미지 를 스냅샷으로 롤백하는 것보다 스냅샷에서 복제하는 것이 더 빠르 며, 기존 상태로 되돌리는 것이 좋습니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 노드에 대한 루트 수준 액세스.

절차

snap rollback옵션, 풀 이름, 이미지 이름 및 스냅 이름을 지정합니다.구문

rbd --pool POOL_NAME snap rollback --snap SNAP_NAME IMAGE_NAME rbd snap rollback POOL_NAME/IMAGE_NAME@SNAP_NAME

예제

[root@rbd-client ~]# rbd --pool rbd snap rollback --snap snapname foo [root@rbd-client ~]# rbd snap rollback rbd/foo@snapname

4.7. 블록 장치 스냅샷 삭제

Ceph 블록 장치의 스냅샷을 삭제합니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 노드에 대한 루트 수준 액세스.

절차

snap rm옵션, 풀 이름, 이미지 이름 및 스냅샷 이름을 지정합니다.구문

rbd --pool POOL_NAME snap rm --snap SNAP_NAME IMAGE_NAME rbd snap rm POOL_NAME-/IMAGE_NAME@SNAP_NAME

예제

[root@rbd-client ~]# rbd --pool rbd snap rm --snap snapname foo [root@rbd-client ~]# rbd snap rm rbd/foo@snapname

이미지에 복제본이 있는 경우 복제된 이미지에는 상위 이미지 스냅샷에 대한 참조가 유지됩니다. 상위 이미지 스냅샷을 삭제하려면 먼저 하위 이미지를 병합해야 합니다.

Ceph OSD 데몬은 데이터를 비동기적으로 삭제하므로 스냅샷을 삭제하면 디스크 공간이 즉시 확보되지 않습니다.

추가 리소스

- 자세한 내용은 Red Hat Ceph Storage Block Device Guide 의 클라 우팅된 이미지 를 참조하십시오.

4.8. 블록 장치 스냅샷 삭제

블록 장치 스냅샷을 제거합니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 노드에 대한 루트 수준 액세스.

절차

snap purge옵션과 이미지 이름을 지정합니다.구문

rbd --pool POOL_NAME snap purge IMAGE_NAME rbd snap purge POOL_NAME/IMAGE_NAME

예제

[root@rbd-client ~]# rbd --pool rbd snap purge foo [root@rbd-client ~]# rbd snap purge rbd/foo

4.9. 블록 장치 스냅샷 이름 변경

블록 장치 스냅샷의 이름을 변경합니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 노드에 대한 루트 수준 액세스.

절차

스냅샷의 이름을 변경하려면 다음을 수행합니다.

구문

rbd snap rename POOL_NAME/IMAGE_NAME@ORIGINAL_SNAPSHOT_NAME POOL_NAME/IMAGE_NAME@NEW_SNAPSHOT_NAME

예제

[root@rbd-client ~]# rbd snap rename data/dataset@snap1 data/dataset@snap2

이렇게 하면 데이터 풀에서

데이터 세트이미지의snap1스냅샷의 이름을snap2로 변경합니다.-

rbd help snap rename명령을 실행하여 스냅샷 이름 바꾸기에 대한 추가 세부 정보를 표시합니다.

4.10. Ceph 블록 장치 계층 지정

Ceph는 블록 장치 스냅샷의 많은 COW(Copy-On-Write) 또는 copy-on-read(COR) 복제본을 생성하는 기능을 지원합니다. 스냅샷 계층을 사용하면 Ceph 블록 장치 클라이언트가 이미지를 매우 빠르게 생성할 수 있습니다. 예를 들어 Linux VM이 작성된 블록 장치 이미지를 생성할 수 있습니다. 그런 다음 이미지를 스냅샷을 만들고 스냅샷을 보호하며 원하는 수만큼 복제본을 만듭니다. 스냅샷은 읽기 전용이므로 스냅샷을 복제하면 의미를 간소화하여 복제본을 신속하게 생성할 수 있습니다.

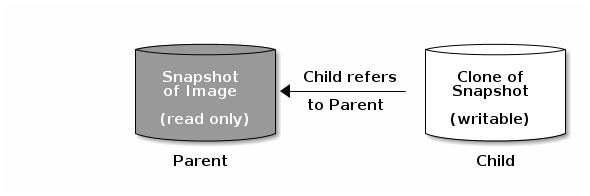

상위 및 라는 용어는 Ceph 블록 장치 스냅샷, 상위 및 스냅샷에서 복제된 해당 이미지를 의미합니다. 이러한 용어는 아래의 명령줄 사용에 중요합니다.

하위

복제된 각 이미지인 하위는 상위 이미지에 대한 참조를 저장하므로 복제된 이미지가 상위 스냅샷을 열고 읽을 수 있습니다. 이 참조는 스냅샷의 정보가 완전히 복제 에 완전히 복사되는 경우 복제본을 병합할 때 제거됩니다.

스냅샷 복제본은 다른 Ceph 블록 장치 이미지와 동일하게 작동합니다. 복제된 이미지의 읽기, 쓰기, 복제, 크기 조정할 수 있습니다. 복제된 이미지에는 특별한 제한이 없습니다. 그러나 스냅샷 복제본은 스냅샷을 참조하므로 복제하기 전에 스냅샷을 보호해야 합니다.

스냅샷 복제본은 COW(Copy-On-Write) 또는 COR(copy-on-read) 복제본일 수 있습니다. COR(Copy-On-Write)을 명시적으로 활성화해야 하는 경우 복제본에 대해 COW(Copy-On-Write)가 항상 활성화됩니다. COW(Copy-On-Write)는 복제 내에서 할당되지 않은 오브젝트에 쓸 때 상위에서 복제본으로 데이터를 복사합니다. COR(Copy-on-read)은 복제본 내의 할당되지 않은 개체에서 읽을 때 상위에서 복제본으로 데이터를 복사합니다. 복제본에서 데이터를 읽는 경우 개체가 복제에 아직 없는 경우에만 상위에서 데이터를 읽습니다. RADOS 블록 장치는 큰 이미지를 여러 오브젝트로 분할합니다. 기본값은 4MB로 설정되고 모든 COW(Copy-On-Write) 및 COR(Copy-on-read) 작업이 전체 개체에서 발생하며 복제본에 1바이트를 작성하면 4MB 개체가 상위에서 읽은 후 이전 COWCOR 작업의 복제본에 아직 존재하지 않는 경우 복제에 기록됩니다.

COR(Copy-on-read)이 활성화되어 있는지 여부에 관계없이 복제본에서 기본 오브젝트를 읽어 충족할 수 없는 모든 읽기는 상위로 다시 라우팅됩니다. 실제로 부모 수에 제한이 없으므로 복제본을 복제할 수 있으므로 이 리라우는 개체가 발견되거나 기본 상위 이미지에 도달할 때까지 계속됩니다. COR(Copy-on-read)이 활성화된 경우 복제본에서 직접 충족하지 못한 모든 읽기는 부모에서 전체 오브젝트를 읽고 복제본에 해당 데이터를 기록하여 나중에 복제본에서 읽을 필요 없이 복제 자체에서 확인할 수 있도록 합니다.

이는 기본적으로 온디맨드 개체 단위 병합 작업입니다. 이는 복제가 다른 지리적 위치에 있는 다른 풀의 부모인 부모로부터 지연 시간이 길어질 때 특히 유용합니다. COR(Copy-on-read)은 읽기의 모호한 대기 시간을 줄입니다. 예를 들어, 복제본에서 1바이트를 읽고 복제본에서 4MB를 읽어야 하므로 처음 몇 개의 읽기 시간이 길어집니다. 그러나 이제 4MB는 부모에서 읽고 복제본에 기록되지만 모든 향후 읽기는 복제 자체에서 제공됩니다.

스냅샷에서 copy-on-read(COR) 복제본을 생성하려면 ceph.conf 파일의 [global] 또는 [client] 섹션에 rbd_clone_copy_on_read = true 를 추가하여 이 기능을 명시적으로 활성화해야 합니다.

추가 리소스

-

플랫링에 대한 자세한 내용은 Red Hat Ceph Storage Block Device Gudie 의 복제된 이미지 추가 섹션을 참조하십시오.

4.11. 블록 장치 스냅샷 보호

복제본은 상위 스냅샷에 액세스합니다. 사용자가 실수로 상위 스냅샷을 삭제하면 모든 복제본이 손상됩니다. 기본적으로 데이터 손실을 방지하려면 스냅샷을 복제하기 전에 보호해야 합니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 노드에 대한 루트 수준 액세스.

절차

다음 명령에

POOL_NAME,IMAGE_NAME및SNAP_SHOT_NAME을 지정합니다.구문

rbd --pool POOL_NAME snap protect --image IMAGE_NAME --snap SNAPSHOT_NAME rbd snap protect POOL_NAME/IMAGE_NAME@SNAPSHOT_NAME

예제

[root@rbd-client ~]# rbd --pool rbd snap protect --image my-image --snap my-snapshot [root@rbd-client ~]# rbd snap protect rbd/my-image@my-snapshot

참고보호된 스냅샷을 삭제할 수 없습니다.

4.12. 블록 장치 스냅샷 복제

블록 장치 스냅샷을 복제하여 동일한 풀 또는 다른 풀 내에 스냅샷의 읽기 또는 쓰기를 생성합니다. 한 가지 사용 사례는 읽기 전용 이미지와 스냅샷을 한 풀의 템플릿으로 유지하고 다른 풀에서 쓰기 가능한 복제본을 유지하는 것입니다.

기본적으로 스냅샷을 보호하려면 복제할 수 있습니다. 복제 전에 스냅샷을 보호할 필요가 없도록 하려면 ceph osd set-require-min-compat-client mimic 을 설정합니다. 또한 마이크보다 더 높은 버전으로 설정할 수 있습니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 노드에 대한 루트 수준 액세스.

절차

스냅샷을 복제하려면 상위 풀, 스냅샷, 하위 풀 및 이미지 이름을 지정해야 합니다.

구문

rbd --pool POOL_NAME --image PARENT_IMAGE --snap SNAP_NAME --dest-pool POOL_NAME --dest CHILD_IMAGE_NAME rbd clone POOL_NAME/PARENT_IMAGE@SNAP_NAME POOL_NAME/CHILD_IMAGE_NAME

예제

[root@rbd-client ~]# rbd --pool rbd --image my-image --snap my-snapshot --dest-pool rbd --dest new-image [root@rbd-client ~]# rbd clone rbd/my-image@my-snapshot rbd/new-image

4.13. 블록 장치 스냅샷 보호 해제

스냅샷을 삭제하려면 먼저 보호를 해제해야 합니다. 또한 복제본의 참조 가 있는 스냅샷을 삭제하지 못 할 수 있습니다. 스냅샷을 삭제하기 전에 스냅샷의 각 복제본을 병합해야 합니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 노드에 대한 루트 수준 액세스.

절차

다음 명령을 실행합니다.

구문

rbd --pool POOL_NAME snap unprotect --image IMAGE_NAME --snap SNAPSHOT_NAME rbd snap unprotect POOL_NAME/IMAGE_NAME@SNAPSHOT_NAME

예제

[root@rbd-client ~]# rbd --pool rbd snap unprotect --image my-image --snap my-snapshot [root@rbd-client ~]# rbd snap unprotect rbd/my-image@my-snapshot

4.14. 스냅샷의 하위 항목 나열

스냅샷의 하위 항목을 나열합니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 노드에 대한 루트 수준 액세스.

절차

스냅샷의 하위 항목을 나열하려면 다음을 실행합니다.

구문

rbd --pool POOL_NAME children --image IMAGE_NAME --snap SNAP_NAME rbd children POOL_NAME/IMAGE_NAME@SNAPSHOT_NAME

예제

rbd --pool rbd children --image my-image --snap my-snapshot rbd children rbd/my-image@my-snapshot

4.15. 복제된 이미지 병합

복제된 이미지에는 상위 스냅샷에 대한 참조가 유지됩니다. 하위 복제본에서 상위 스냅샷에 대한 참조를 제거하면 스냅샷에서 복제본으로 정보를 복사하여 이미지를 효과적으로 "병합"합니다. 복제본 병합에 걸리는 시간은 스냅샷 크기와 함께 증가합니다. 병합된 이미지에는 스냅샷의 모든 정보가 포함되어 있으므로 병합된 이미지는 계층화된 복제본보다 더 많은 스토리지 공간을 사용합니다.

이미지에서 deep flatten 기능을 활성화하면 이미지 복제가 기본적으로 상위에서 해제됩니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 노드에 대한 루트 수준 액세스.

절차

하위 이미지와 연결된 상위 이미지 스냅샷을 삭제하려면 먼저 하위 이미지를 병합해야 합니다.

구문

rbd --pool POOL_NAME flatten --image IMAGE_NAME rbd flatten POOL_NAME/IMAGE_NAME

예제

[root@rbd-client ~]# rbd --pool rbd flatten --image my-image [root@rbd-client ~]# rbd flatten rbd/my-image

5장. Ceph 블록 장치 미러링

스토리지 관리자는 Red Hat Ceph Storage 클러스터 간에 데이터 이미지를 미러링하여 Ceph 블록 장치에 다른 중복 계층을 추가할 수 있습니다. Ceph 블록 장치 미러링을 이해하고 사용하면 사이트 장애와 같은 데이터 손실을 보호할 수 있습니다. Ceph 블록 장치 미러링에는 단방향 미러링 또는 양방향 미러링의 두 가지 구성이 있으며 풀 및 개별 이미지에서 미러링을 구성할 수 있습니다.

5.1. 사전 요구 사항

- 최소 2개의 정상 실행 중인 Red Hat Ceph Storage 클러스터.

- 두 스토리지 클러스터 간의 네트워크 연결.

- 각 Red Hat Ceph Storage 클러스터의 Ceph 클라이언트 노드에 액세스할 수 있습니다.

5.2. Ceph 블록 장치 미러링

RADOS Block Device(RBD) 미러링은 둘 이상의 Ceph 스토리지 클러스터 간에 Ceph 블록 장치 이미지의 비동기 복제 프로세스입니다. RBD Mirroring은 서로 다른 지리적 위치에서 Ceph 스토리지 클러스터를 찾아 사이트 재해에서 복구하는 데 도움이 될 수 있습니다. 저널 기반 Ceph 블록 장치 미러링은 읽기 및 쓰기, 블록 장치 크기 조정, 스냅샷, 복제본 및 플랫화를 포함하여 이미지에 대한 특정 시점의 일관성 있는 복제본을 보장합니다.

RBD 미러링은 전용 잠금과 저널링 기능을 사용하여 해당 문제가 발생하는 순서대로 이미지에 대한 모든 수정 사항을 기록합니다. 이렇게 하면 이미지의 충돌 불일치 미러를 사용할 수 있습니다.

블록 장치 이미지를 미러링하는 기본 및 보조 풀은 동일한 용량 및 성능 특성을 유지해야 하며 과도한 대기 시간 없이 미러링을 보장하기 위한 적절한 대역폭이 있어야 합니다. 예를 들어 기본 스토리지 클러스터의 이미지에 XMB/s 평균 쓰기 처리량이 있는 경우 네트워크는 보조 사이트에 대한 네트워크 연결에서 N * X 처리량과 N 이미지를 미러링하는 데 Y%의 안전 요소를 지원해야 합니다.

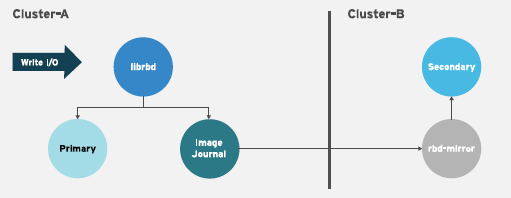

rbd-mirror 데몬은 원격 기본 이미지에서 변경 사항을 가져오고 이러한 변경 사항을 로컬 비기본 이미지에 기록하여 하나의 Ceph 스토리지 클러스터에서 다른 Ceph 스토리지 클러스터에 이미지를 동기화합니다. rbd-mirror 데몬은 단방향 미러링을 위해 단일 Ceph 스토리지 클러스터에서 또는 미러링 관계에 참여하는 양방향 미러링을 위해 두 개의 Ceph 스토리지 클러스터에서 실행할 수 있습니다.

RBD 미러링이 작동하려면 단방향 또는 양방향 복제를 사용하는 경우 몇 가지 가정이 수행됩니다.

- 동일한 이름의 풀이 두 스토리지 클러스터에 있습니다.

- 풀에는 미러링하려는 저널 지원 이미지가 포함되어 있습니다.

단방향 또는 양방향 복제에서 rbd-mirror 의 각 인스턴스는 다른 Ceph 스토리지 클러스터에 동시에 연결할 수 있어야 합니다. 또한 네트워크에는 미러링을 처리하기 위해 두 데이터 센터 사이트 간에 충분한 대역폭이 있어야 합니다.

단방향 복제

한 스토리지 클러스터의 기본 이미지 또는 이미지 풀이 보조 스토리지 클러스터에 복제되는 것을 의미합니다. 단방향 미러링은 여러 보조 스토리지 클러스터에 대한 복제도 지원합니다.

보조 스토리지 클러스터에서 이미지는 기본이 아닌 복제본입니다. 즉 Ceph 클라이언트는 이미지에 쓸 수 없습니다. 데이터가 주 스토리지 클러스터에서 보조 스토리지 클러스터로 미러링되면 rbd-mirror 는 보조 스토리지 클러스터에서만 실행됩니다.

일방향 미러링이 작동하려면 몇 가지 가정이 수행됩니다.

- 두 개의 Ceph 스토리지 클러스터가 있으며 기본 스토리지 클러스터에서 보조 스토리지 클러스터로 이미지를 복제하려고 합니다.

-

보조 스토리지 클러스터에는

rbd-mirror데몬을 실행하는 Ceph 클라이언트 노드가 연결되어 있습니다.rbd-mirror데몬은 이미지를 보조 스토리지 클러스터에 동기화하도록 기본 스토리지 클러스터에 연결합니다.

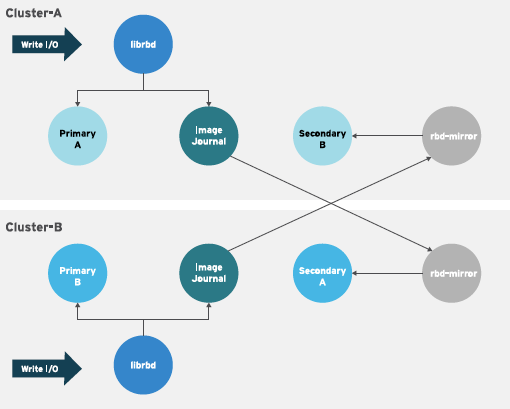

양방향 복제

양방향 복제는 기본 클러스터에 rbd-mirror 데몬을 추가하여 이미지를 시연하고 보조 클러스터에서 승격할 수 있습니다. 그런 다음 보조 클러스터의 이미지를 변경하면 보조 클러스터에서 보조 클러스터로 리디렉션 방향으로 복제됩니다. 두 클러스터에 모두 rbd-mirror 가 실행 중이어야 합니다. 두 클러스터에는 두 클러스터에서 이미지를 승격하고 설명할 수 있도록 rbd-mirror가 실행되고 있어야 합니다. 현재 양방향 복제는 두 사이트 간에만 지원됩니다.

양방향 미러링이 작동하려면 몇 가지 가정이 수행됩니다.

- 두 개의 스토리지 클러스터가 있으며 두 가지 방향으로 이미지를 복제할 수 있습니다.

-

두 스토리지 클러스터에는

rbd-mirror데몬을 실행하는 클라이언트 노드가 연결되어 있습니다. 보조 스토리지 클러스터에서 실행 중인rbd-mirror데몬은 기본 스토리지 클러스터에 연결하여 이미지를 보조에 동기화하고, 기본 스토리지 클러스터에서 실행 중인rbd-mirror데몬이 보조 스토리지 클러스터에 연결하여 이미지를 기본 클러스터에 동기화합니다.

Red Hat Ceph Storage 4에서는 단일 클러스터에서 여러 개의 활성 rbd-mirror 데몬을 실행할 수 있습니다.

미러링 모드

미러링은 미러 피어링 스토리지 클러스터가 있는 풀별로 구성됩니다. Ceph는 풀의 이미지 유형에 따라 두 가지 미러링 모드를 지원합니다.

- 풀 모드

- 저널링 기능이 활성화된 풀의 모든 이미지가 미러링됩니다.

- 이미지 모드

- 풀 내 특정 이미지 하위 집합만 미러링됩니다. 각 이미지에 대해 별도로 미러링을 활성화해야 합니다.

이미지 상태

이미지를 수정할 수 있는지 여부는 상태에 따라 달라집니다.

- 기본 상태의 이미지를 수정할 수 있습니다.

- 기본이 아닌 상태의 이미지는 수정할 수 없습니다.

이미지는 이미지에서 미러링을 처음 활성화하면 자동으로 primary로 승격됩니다. 승격이 발생할 수 있습니다.

- 풀 모드에서 미러링을 활성화하여 암시적으로 수행됩니다.

- 특정 이미지 미러링을 활성화하여 명시적으로 다음을 수행합니다.

기본 이미지를 시연하고 기본 이미지가 아닌 이미지를 승격할 수 있습니다.

추가 리소스

- 자세한 내용은 Red Hat Ceph Storage Block Device Guide 의 이미지 승격 및 데모 섹션을 참조하십시오.

5.3. Ansible을 사용하여 단방향 미러링 구성

이 절차에서는 ceph-ansible 을 사용하여 site-b라는 기본 스토리지 클러스터에서 일방향 이미지 복제 를 라고 하는 보조 스토리지 클러스터에 구성합니다. 다음 예에서 site- b데이터 는 미러링할 이미지를 포함하는 풀의 이름입니다.

사전 요구 사항

- Red Hat Ceph Storage 클러스터가 실행 중인 2개입니다.

- Ceph 클라이언트 노드.

- 동일한 이름의 풀이 두 클러스터에 있습니다.

- 풀 내의 이미지에는 저널 기반 미러링에 사용할 수 있는 독점 잠금 및 저널링이 활성화되어 있어야 합니다.

단방향 복제를 사용하는 경우 여러 보조 스토리지 클러스터에 미러링할 수 있습니다.

절차

이미지가 시작된 클러스터에서 이미지에서 배타적 잠금 및 저널링 기능을 활성화합니다.

새 이미지 의 경우

--image-feature옵션을 사용합니다.구문

rbd create IMAGE_NAME --size MEGABYTES --pool POOL_NAME --image-feature FEATURE[,FEATURE]

예제

[root@rbd-client ~]# rbd create image1 --size 1024 --pool data --image-feature exclusive-lock,journaling

기존 이미지 의 경우

rbd 기능 enable 명령을사용합니다.구문

rbd feature enable POOL_NAME/IMAGE_NAME FEATURE_NAME

예제

[root@rbd-client ~]# rbd feature enable data/image1 exclusive-lock,journaling

기본적으로 모든 새 이미지에서 배타적 잠금 및 저널링을 활성화하려면 Ceph 구성 파일에 다음 설정을 추가합니다.

rbd_default_features = 125

site-a클러스터에서 다음 단계를 완료합니다.모니터 노드에서

rbd-mirror데몬이 클러스터에 연결하는 데 사용할 사용자를 만듭니다. 이 예제에서는site-a사용자를 생성하고 이 키를site-a.client.site-a.keyring이라는 파일에 출력합니다.구문

ceph auth get-or-create client.CLUSTER_NAME mon 'profile rbd' osd 'profile rbd pool=data' -o /etc/ceph/CLUSTER_NAME.client.USER_NAME.keyring

예제

[root@mon ~]# ceph auth get-or-create client.site-a mon 'profile rbd' osd 'profile rbd pool=data' -o /etc/ceph/site-a.client.site-a.keyring

-

모니터링 노드에서 Ceph 구성 파일 및 새로 생성된 키 파일을

site-b모니터 및 클라이언트 노드로 복사합니다. -

Ceph 구성 파일의 이름을

ceph.conf에서 CLUSTER-NAME.conf로 변경합니다. 이 예제에서 파일은/etc/ceph/site-a.conf입니다.

site-b클러스터에서 다음 단계를 완료합니다.-

Ansible 관리 노드에서 Ansible 인벤토리 파일에

[rbdmirrors]그룹을 추가합니다. 일반적인 인벤토리 파일은/etc/ansible/hosts입니다. [rbdmirrors]그룹에서rbd-mirrors 데몬을 실행할site-b클라이언트 노드의 이름을 추가합니다. 데몬은site-a에서site-b로 이미지 변경 사항을 가져옵니다.[rbdmirrors] ceph-client

/usr/share/ceph-ansible/디렉터리로 이동합니다.[root@admin ~]# cd /usr/share/ceph-ansible

group_vars/

rbdmirrors.yml.sample을 group_vars/rbdmirrors.yml에 복사하여 새rbdmirrors.yml 파일을 만듭니다.[root@admin ceph-ansible]# cp group_vars/rbdmirrors.yml.sample group_vars/rbdmirrors.yml

-

편집할

group_vars/rbdmirrors.yml파일을 엽니다. ceph_rbd_mirror_configure를true로 설정합니다.ceph_rbd_mirror_pool을 이미지를 미러링할 풀로 설정합니다. 이 예제에서데이터는 풀 이름입니다.ceph_rbd_mirror_configure: true ceph_rbd_mirror_pool: "data"

기본적으로

ceph-ansible은 풀의 모든 이미지를 미러링하는 풀 모드를 사용하여 미러링을 구성합니다. 미러링이 명시적으로 활성화된 이미지만 미러링된 이미지만 활성화하는 이미지 모드를 활성화합니다. 이미지 모드를 활성화하려면ceph_rbd_mirror_mode를image로 설정합니다.ceph_rbd_mirror_mode: image

rbd-mirror에서 가져올 클러스터의 이름을 설정합니다. 이 예제에서 다른 클러스터는site-a입니다.ceph_rbd_mirror_remote_cluster: "site-a"

Ansible 관리 노드에서

ceph_rbd_mirror_remote_user를 사용하여 키의 사용자 이름을 설정합니다. 키를 만들 때 사용한 것과 동일한 이름을 사용합니다. 이러한 예에서 사용자는client.site-a라는 이름으로 지정됩니다.ceph_rbd_mirror_remote_user: "client.site-a"

ceph-ansible 사용자로 Ansible 플레이북을 실행합니다.

베어 메탈 배포:

[user@admin ceph-ansible]$ ansible-playbook site.yml --limit rbdmirrors -i hosts

컨테이너 배포:

[ansible@admin ceph-ansible]$ ansible-playbook site-container.yml --limit rbdmirrors -i hosts

-

Ansible 관리 노드에서 Ansible 인벤토리 파일에

site-a및site-b클러스터 모두에서 원하는 이미지에서 미러링을 명시적으로 활성화합니다.구문

저널 기반 미러링:

rbd mirror image enable POOL/IMAGE

스냅샷 기반 미러링:

rbd mirror image enable POOL/IMAGE snapshot

예제

[root@mon ~]# rbd mirror image enable data/image1 [root@mon ~]# rbd mirror image enable data/image1 snapshot

참고새 이미지를 피어 클러스터에 미러링할 때마다 이 단계를 반복합니다.

미러링 상태를 확인합니다.

site-b클러스터의 Ceph Monitor 노드에서 다음 명령을 실행합니다.예제

저널 기반 미러링:

[root@mon ~]# rbd mirror image status data/image1 image1: global_id: 7d486c3f-d5a1-4bee-ae53-6c4f1e0c8eac state: up+replaying 1 description: replaying, master_position=[object_number=3, tag_tid=1, entry_tid=3], mirror_position=[object_number=3, tag_tid=1, entry_tid=3], entries_behind_master=0 last_update: 2019-04-22 13:19:27스냅샷 기반 미러링:

[root@mon ~]# rbd mirror image status data/image1 image1: global_id: 06acc9e6-a63d-4aa1-bd0d-4f3a79b0ae33 state: up+replaying 1 description: replaying, {"bytes_per_second":0.0,"bytes_per_snapshot":0.0,"local_snapshot_timestamp":1642689843,"remote_snapshot_timestamp":1642689843,"replay_state":"idle"} service: admin on ceph-rbd2-vasi-43-5hwia4-node2 last_update: 2022-01-20 12:41:57참고사이트 간 연결에 따라 미러링은 이미지를 동기화하는 데 시간이 오래 걸릴 수 있습니다.

5.4. Ansible을 사용하여 양방향 미러링 구성

이 절차에서는 ceph-ansible 을 사용하여 양방향 복제를 구성하여 site-a 및 site-b 라고 하는 두 클러스터 간의 이미지를 미러링할 수 있습니다. 다음 예에서 데이터 는 미러링할 이미지를 포함하는 풀의 이름입니다.

양방향 미러링은 두 클러스터의 동일한 이미지에 동시 쓰기를 허용하지 않습니다. 이미지는 한 클러스터에서 승격되고 다른 클러스터에서 강등됩니다. 상태에 따라 한 방향 또는 다른 방향으로 미러링됩니다.

사전 요구 사항

- Red Hat Ceph Storage 클러스터가 실행 중인 2개입니다.

- 각 클러스터에는 클라이언트 노드가 있습니다.

- 동일한 이름의 풀이 두 클러스터에 있습니다.

- 풀 내의 이미지에는 저널 기반 미러링에 사용할 수 있는 독점 잠금 및 저널링이 활성화되어 있어야 합니다.

절차

이미지가 시작된 클러스터에서 이미지에서 배타적 잠금 및 저널링 기능을 활성화합니다.

새 이미지 의 경우

--image-feature옵션을 사용합니다.구문

rbd create IMAGE_NAME --size MEGABYTES --pool POOL_NAME --image-feature FEATURE[,FEATURE]

예제

[root@rbd-client ~]# rbd create image1 --size 1024 --pool data --image-feature exclusive-lock,journaling

기존 이미지 의 경우

rbd 기능 enable 명령을사용합니다.구문

rbd feature enable POOL_NAME/IMAGE_NAME FEATURE_NAME

예제

[root@rbd-client ~]# rbd feature enable data/image1 exclusive-lock,journaling

기본적으로 모든 새 이미지에서 배타적 잠금 및 저널링을 활성화하려면 Ceph 구성 파일에 다음 설정을 추가합니다.

rbd_default_features = 125

site-a클러스터에서 다음 단계를 완료합니다.모니터 노드에서

rbd-mirror데몬이 클러스터에 연결하는 데 사용할 사용자를 만듭니다. 이 예제에서는site-a사용자를 생성하고 해당 키를site-a.client.site-a.keyring이라는 파일에 출력하고 Ceph 구성 파일은/etc/ceph/site-a.conf입니다.구문

ceph auth get-or-create client.PRIMARY_CLUSTER_NAME mon 'profile rbd' osd 'profile rbd pool=data' -o /etc/ceph/PRIMARY_CLUSTER_NAME.client.USER_NAME.keyring -c /etc/ceph/PRIMARY_CLUSTER_NAME.conf

예제

[root@mon ~]# ceph auth get-or-create client.site-a mon 'profile rbd' osd 'profile rbd pool=data' -o /etc/ceph/site-a.client.site-a.keyring -c /etc/ceph/site-a.conf

인증 키를

site-b클러스터에 복사합니다.rbd-daemon이 실행될site-b클러스터의 클라이언트 노드에 파일을 복사합니다. 파일을/etc/ceph/site-a.client.site-a.keyring에 저장합니다.구문

scp /etc/ceph/PRIMARY_CLUSTER_NAME.client.USER_NAME.keyring root@SECONDARY_CLIENT_NODE_NAME:/etc/ceph/PRIMARY_CLUSTER_NAME.client.USER_NAME.keyring

예제

[root@mon ~]# scp /etc/ceph/site-a.client.site-a.keyring root@client.site-b:/etc/ceph/site-a.client.site-a.keyring

모니터 노드에서

site-b모니터 노드 및 클라이언트 노드로 Ceph 구성 파일을 복사합니다. 이 예제의 Ceph 구성 파일은/etc/ceph/site-a.conf입니다.구문

scp /etc/ceph/PRIMARY_CLUSTER_NAME.conf root@SECONDARY_MONITOR_NODE_NAME:/etc/ceph/PRIMARY_CLUSTER_NAME.conf scp /etc/ceph/PRIMARY_CLUSTER_NAME.conf user@SECONDARY_CLIENT_NODE_NAME:/etc/ceph/PRIMARY_CLUSTER_NAME.conf

예제

[root@mon ~]# scp /etc/ceph/site-a.conf root@mon.site-b:/etc/ceph/site-a.conf [root@mon ~]# scp /etc/ceph/site-a.conf user@client.site-b:/etc/ceph/site-a.conf

site-b클러스터에서 다음 단계를 완료합니다.-

site-a에서site-b로 미러링을 구성합니다. Ansible 관리 노드에서 Ansible 인벤토리 파일(일반적으로/usr/share/ceph-ansible/hosts)에[rbdmirrors]그룹을 추가합니다. [rbdmirrors]그룹에서rbd-mirrors 데몬에서 실행할site-b클라이언트 노드의 이름을 추가합니다. 이 데몬은site-a에서site-b로 이미지 변경 사항을 가져옵니다.예제

[rbdmirrors] client.site-b

/usr/share/ceph-ansible/디렉터리로 이동합니다.[root@admin ~]$ cd /usr/share/ceph-ansible

group_vars/

rbdmirrors.yml.sample을 group_vars/rbdmirrors.yml에 복사하여 새rbdmirrors.yml 파일을 만듭니다.[root@admin ceph-ansible]# cp group_vars/rbdmirrors.yml.sample group_vars/rbdmirrors.yml

-

group_vars/rbdmirrors.yml파일을 편집하기 위해 을 엽니다. ceph_rbd_mirror_configure를true로 설정하고ceph_rbd_mirror_pool을 미러할 풀로 설정합니다. 이 예제에서데이터는 풀 이름입니다.ceph_rbd_mirror_configure: true ceph_rbd_mirror_pool: "data"

기본적으로

ceph-ansible은 풀의 모든 이미지를 미러링하는 풀 모드를 사용하여 미러링을 구성합니다. 미러링이 명시적으로 활성화된 이미지만 미러링된 이미지만 활성화하는 이미지 모드를 활성화합니다. 이미지 모드를 활성화하려면ceph_rbd_mirror_mode를image로 설정합니다.ceph_rbd_mirror_mode: image

group_vars/rbdmirrors.yml파일에서rbd-mirror에서 클러스터의 이름을 설정합니다. 이 예제에서 다른 클러스터는site-a입니다.ceph_rbd_mirror_remote_cluster: "site-a"

Ansible 관리 노드에서

group_vars/rbdmirrors.yml파일에서ceph_rbd_mirror_remote_user를 사용하여 키의 사용자 이름을 설정합니다. 키를 만들 때 사용한 것과 동일한 이름을 사용합니다. 이러한 예에서 사용자는client.site-a라는 이름으로 지정됩니다.ceph_rbd_mirror_remote_user: "client.site-a"

ansible 사용자로 Ansible 플레이북을 실행합니다.

베어 메탈 배포:

[user@admin ceph-ansible]$ ansible-playbook site.yml --limit rbdmirrors -i hosts

컨테이너 배포:

[user@admin ceph-ansible]$ ansible-playbook site-container.yml --limit rbdmirrors -i hosts

-

미러링 상태를 확인합니다.

site-b클러스터의 Ceph Monitor 노드에서 다음 명령을 실행합니다.예제

저널 기반 미러링:

[root@mon ~]# rbd mirror image status data/image1 image1: global_id: 7d486c3f-d5a1-4bee-ae53-6c4f1e0c8eac state: up+replaying 1 description: replaying, master_position=[object_number=3, tag_tid=1, entry_tid=3], mirror_position=[object_number=3, tag_tid=1, entry_tid=3], entries_behind_master=0 last_update: 2021-04-22 13:19:27스냅샷 기반 미러링:

[root@mon ~]# rbd mirror image status data/image1 image1: global_id: 06acc9e6-a63d-4aa1-bd0d-4f3a79b0ae33 state: up+replaying 1 description: replaying, {"bytes_per_second":0.0,"bytes_per_snapshot":0.0,"local_snapshot_timestamp":1642689843,"remote_snapshot_timestamp":1642689843,"replay_state":"idle"} service: admin on ceph-rbd2-vasi-43-5hwia4-node2 last_update: 2022-01-20 12:41:57참고사이트 간 연결에 따라 미러링은 이미지를 동기화하는 데 시간이 오래 걸릴 수 있습니다.

site-b클러스터에서 다음 단계를 완료합니다. 단계는 주로 위와 동일합니다.모니터 노드에서

rbd-mirror데몬이 클러스터에 연결하는 데 사용할 사용자를 만듭니다. 이 예제에서는site-b사용자를 생성하고 해당 키를site-b.client.site-b.keyring이라는 파일에 출력하고 Ceph 구성 파일은/etc/ceph/site-b.conf입니다.구문

ceph auth get-or-create client.SECONDARY_CLUSTER_NAME mon 'profile rbd' osd 'profile rbd pool=data' -o /etc/ceph/SECONDARY_CLUSTER_NAME.client.USER_NAME.keyring -c /etc/ceph/SECONDARY_CLUSTER_NAME.conf

예제

[root@mon ~]# ceph auth get-or-create client.site-b mon 'profile rbd' osd 'profile rbd pool=data' -o /etc/ceph/site-b.client.site-b.keyring -c /etc/ceph/site-b.conf

인증 키를

site-a클러스터에 복사합니다.rbd의 클라이언트 노드에 파일을 복사합니다. 파일을-daemon이 실행될 클러스터/etc/ceph/site-b.client.site-b.keyring에 저장합니다.구문

scp /etc/ceph/SECONDARY_CLUSTER_NAME.client.USER_NAME.keyring root@PRIMARY_CLIENT_NODE_NAME:/etc/ceph/SECONDARY_CLUSTER_NAME.client.USER_NAME.keyring

예제

[root@mon ~]# scp /etc/ceph/site-b.client.site-b.keyring root@client.site-a:/etc/ceph/site-b.client.site-b.keyring

모니터 노드에서

site-amonitor 노드 및 클라이언트 노드로 Ceph 구성 파일을 복사합니다. 이 예제의 Ceph 구성 파일은/etc/ceph/site-b.conf입니다.구문

scp /etc/ceph/SECONDARY_CLUSTER_NAME.conf root@PRIMARY_MONITOR_NODE_NAME:/etc/ceph/SECONDARY_CLUSTER_NAME.conf scp /etc/ceph/SECONDARY_CLUSTER_NAME.conf user@PRIMARY_CLIENT_NODE_NAME:/etc/ceph/SECONDARY_CLUSTER_NAME.conf

예제

[root@mon ~]# scp /etc/ceph/site-b.conf root@mon.site-a:/etc/ceph/site-b.conf [root@mon ~]# scp /etc/ceph/site-b.conf user@client.site-a:/etc/ceph/site-b.conf

site-a클러스터에서 다음 단계를 완료합니다.-

site-b에서site-a로 미러링을 구성합니다. Ansible 관리 노드에서 Ansible 인벤토리 파일(일반적으로/usr/share/ceph-ansible/hosts)에[rbdmirrors]그룹을 추가합니다. [rbdmirrors]그룹에서rbd-mirrors 데몬에서 실행할site-a클라이언트 노드의 이름을 추가합니다. 이 데몬은site-b에서site-a로 이미지 변경 사항을 가져옵니다.예제

[rbdmirrors] client.site-a

/usr/share/ceph-ansible/디렉터리로 이동합니다.[root@admin ~]# cd /usr/share/ceph-ansible

group_vars/

rbdmirrors.yml.sample을 group_vars/rbdmirrors.yml에 복사하여 새rbdmirrors.yml 파일을 만듭니다.[root@admin ceph-ansible]# cp group_vars/rbdmirrors.yml.sample group_vars/rbdmirrors.yml

-

group_vars/rbdmirrors.yml파일을 편집하기 위해 을 엽니다. ceph_rbd_mirror_configure를true로 설정하고ceph_rbd_mirror_pool을 미러할 풀로 설정합니다. 이 예제에서데이터는 풀 이름입니다.ceph_rbd_mirror_configure: true ceph_rbd_mirror_pool: "data"

기본적으로

ceph-ansible은 풀의 모든 이미지를 미러링하는 풀 모드를 사용하여 미러링을 구성합니다. 미러링이 명시적으로 활성화된 이미지만 미러링된 이미지만 활성화하는 이미지 모드를 활성화합니다. 이미지 모드를 활성화하려면ceph_rbd_mirror_mode를image로 설정합니다.ceph_rbd_mirror_mode: image

Ansible 관리 노드에서

group_vars/rbdmirrors.yml파일에서rbd-mirror에서 클러스터의 이름을 설정합니다. 예를 들어 다른 클러스터의 이름은site-b입니다.ceph_rbd_mirror_remote_cluster: "site-b"

Ansible 관리 노드에서

group_vars/rbdmirrors.yml파일에서ceph_rbd_mirror_remote_user를 사용하여 키의 사용자 이름을 설정합니다. 이 예제에서는 user의 이름은client.site-b입니다.ceph_rbd_mirror_remote_user: "client.site-b"

관리 노드에서 Ansible 사용자로 Ansible 플레이북을 실행합니다.

베어 메탈 배포:

[user@admin ceph-ansible]$ ansible-playbook site.yml --limit rbdmirrors -i hosts

컨테이너 배포:

[user@admin ceph-ansible]$ ansible-playbook site-container.yml --limit rbdmirrors -i hosts

-

site-a및site-b클러스터 모두에서 원하는 이미지에서 미러링을 명시적으로 활성화합니다.구문

저널 기반 미러링:

rbd mirror image enable POOL/IMAGE

스냅샷 기반 미러링:

rbd mirror image enable POOL/IMAGE snapshot

예제

[root@mon ~]# rbd mirror image enable data/image1 [root@mon ~]# rbd mirror image enable data/image1 snapshot

참고새 이미지를 피어 클러스터에 미러링할 때마다 이 단계를 반복합니다.

미러링 상태를 확인합니다.

site-a클러스터의 클라이언트 노드에서 다음 명령을 실행합니다.예제

저널 기반 미러링:

[root@mon ~]# rbd mirror image status data/image1 image1: global_id: 08027096-d267-47f8-b52e-59de1353a034 state: up+stopped 1 description: local image is primary last_update: 2021-04-16 15:45:31스냅샷 기반 미러링:

[root@mon ~]# rbd mirror image status data/image1 image1: global_id: 47fd1aae-5f19-4193-a5df-562b5c644ea7 state: up+stopped 1 description: local image is primary service: admin on ceph-rbd1-vasi-43-5hwia4-node2 last_update: 2022-01-20 12:42:54 peer_sites: name: rbd-mirror.site-b state: up+replaying description: replaying, {"bytes_per_second":0.0,"bytes_per_snapshot":0.0,"local_snapshot_timestamp":1642693094,"remote_snapshot_timestamp":1642693094,"replay_state":"idle"} last_update: 2022-01-20 12:42:59 snapshots: 5 .mirror.primary.47fd1aae-5f19-4193-a5df-562b5c644ea7.dda146c6-5f21-4e75-ba93-660f6e57e301 (peer_uuids:[bfd09289-c9c9-40c8-b2d3-ead9b6a99a45])

5.5. 명령줄 인터페이스를 사용하여 단방향 미러링 구성

다음 절차에서는 기본 스토리지 클러스터에서 보조 스토리지 클러스터로 풀의 단방향 복제를 구성합니다.

단방향 복제를 사용하는 경우 여러 보조 스토리지 클러스터에 미러링할 수 있습니다.

이 섹션의 예는 기본 이미지를 site-a 로 참조하며 이미지를 site-b 로 복제하는 보조 스토리지 클러스터를 참조하여 두 스토리지 클러스터를 구분합니다. 이 예제에서 사용되는 풀 이름을 data 라고 합니다.

사전 요구 사항

- Red Hat Ceph Storage 클러스터 최소 2개 이상 정상 및 실행 중인.

- 각 스토리지 클러스터의 Ceph 클라이언트 노드에 대한 루트 수준 액세스.

- 관리자 수준의 기능이 있는 CephX 사용자.

- 풀 내의 이미지에는 저널 기반 미러링에 사용할 수 있는 독점 잠금 및 저널링이 활성화되어 있어야 합니다.

절차

site-b스토리지 클러스터에 연결된 클라이언트 노드에rbd-mirror패키지를 설치합니다.Red Hat Enterprise Linux 7

[root@rbd-client ~]# yum install rbd-mirror

Red Hat Enterprise Linux 8

[root@rbd-client ~]# dnf install rbd-mirror

참고패키지는 Red Hat Ceph Storage Tools 리포지토리에서 제공됩니다.

이미지에서 배타적 잠금 및 저널링 기능을 활성화합니다.

새 이미지 의 경우

--image-feature옵션을 사용합니다.구문

rbd create IMAGE_NAME --size MEGABYTES --pool POOL_NAME --image-feature FEATURE [,FEATURE]

예제

[root@rbd-client ~]# rbd create image1 --size 1024 --pool data --image-feature exclusive-lock,journaling

기존 이미지 의 경우

rbd 기능 enable 명령을사용합니다.구문

rbd feature enable POOL_NAME/IMAGE_NAME FEATURE [,FEATURE]

예제

[root@rbd-client ~]# rbd feature enable data/image1 exclusive-lock,journaling

기본적으로 모든 새 이미지에서 배타적 잠금 및 저널링을 활성화하려면 Ceph 구성 파일에 다음 설정을 추가합니다.

rbd_default_features = 125

미러링 모드(풀 또는 이미지 모드)를 선택합니다.

중요스냅샷 기반 미러링에 이미지 모드를 사용합니다.

풀 모드 활성화:

구문

rbd mirror pool enable POOL_NAME MODE

예제

[root@rbd-client ~]# rbd mirror pool enable data pool

이 예제에서는

data라는 전체 풀을 미러링할 수 있습니다.이미지 모드 활성화:

구문

rbd mirror pool enable POOL_NAME MODE

예제

[root@rbd-client ~]# rbd mirror pool enable data image

이 예제에서는

data라는 풀에서 이미지 모드 미러링을 활성화합니다.미러링이 성공적으로 활성화되었는지 확인합니다.

구문

rbd mirror pool info POOL_NAME예제

[root@rbd-client ~]# rbd mirror pool info data Mode: image Site Name: 94cbd9ca-7f9a-441a-ad4b-52a33f9b7148 Peer Sites: none

site-a클러스터에서 다음 단계를 완료합니다.Ceph 클라이언트 노드에서 사용자를 생성합니다.

구문

ceph auth get-or-create client.PRIMARY_CLUSTER_NAME mon 'profile rbd-mirror' osd 'profile rbd' -o /etc/ceph/ceph.PRIMARY_CLUSTER_NAME.keyring

예제

[root@rbd-client-site-a ~]# ceph auth get-or-create client.rbd-mirror.site-a mon 'profile rbd-mirror' osd 'profile rbd' -o /etc/ceph/ceph.client.rbd-mirror.site-a.keyring

인증 키를

site-b클러스터에 복사합니다.구문

scp /etc/ceph/ceph.PRIMARY_CLUSTER_NAME.keyring root@SECONDARY_CLUSTER:_PATH_

예제

[root@rbd-client-site-a ~]# scp /etc/ceph/ceph.client.rbd-mirror.site-a.keyring root@rbd-client-site-b:/etc/ceph/

Ceph 클라이언트 노드에서 스토리지 클러스터 피어를 부트스트랩합니다.

스토리지 클러스터 피어를 풀에 등록합니다.

구문

rbd mirror pool peer bootstrap create --site-name LOCAL_SITE_NAME POOL_NAME > PATH_TO_BOOTSTRAP_TOKEN

예제

[root@rbd-client-site-a ~]# rbd mirror pool peer bootstrap create --site-name rbd-mirror.site-a data > /root/bootstrap_token_rbd-mirror.site-a

참고이 예제 bootstrap 명령은

client.rbd-mirror-peerCeph 사용자를 생성합니다.부트스트랩 토큰 파일을

site-b스토리지 클러스터에 복사합니다.구문

scp PATH_TO_BOOTSTRAP_TOKEN root@SECONDARY_CLUSTER:/root/

예제

[root@rbd-client-site-a ~]# scp /root/bootstrap_token_site-a root@ceph-rbd2:/root/

site-b클러스터에서 다음 단계를 완료합니다.클라이언트 노드에서 사용자를 생성합니다.

구문

ceph auth get-or-create client.SECONDARY_CLUSTER_NAME mon 'profile rbd-mirror' osd 'profile rbd' -o /etc/ceph/ceph.SECONDARY_CLUSTER_NAME.keyring

예제

[root@rbd-client-site-b ~]# ceph auth get-or-create client.rbd-mirror.site-b mon 'profile rbd-mirror' osd 'profile rbd' -o /etc/ceph/ceph.client.rbd-mirror.site-b.keyring

인증 키를 Ceph 클라이언트 노드인

site-a클러스터에 복사합니다.구문

scp /etc/ceph/ceph.SECONDARY_CLUSTER_NAME.keyring root@PRIMARY_CLUSTER:_PATH_

예제

[root@rbd-client-site-b ~]# scp /etc/ceph/ceph.client.rbd-mirror.site-b.keyring root@rbd-client-site-a:/etc/ceph/

부트스트랩 토큰을 가져옵니다.

구문

rbd mirror pool peer bootstrap import --site-name LOCAL_SITE_NAME --direction rx-only POOL_NAME PATH_TO_BOOTSTRAP_TOKEN

예제

[root@rbd-client-site-b ~]# rbd mirror pool peer bootstrap import --site-name rbd-mirror.site-b --direction rx-only data /root/bootstrap_token_rbd-mirror.site-a

참고단방향 RBD 미러링의 경우 피어를 부트 스트랩할 때 양방향 미러링이 기본값이므로

--direction rx-only인수를 사용해야 합니다.클라이언트 노드에서

rbd-mirror데몬을 활성화하고 시작합니다.구문

systemctl enable ceph-rbd-mirror.target systemctl enable ceph-rbd-mirror@rbd-mirror.CLIENT_ID systemctl start ceph-rbd-mirror@rbd-mirror.CLIENT_ID

CLIENT_ID를 이전에 만든 Ceph 사용자로 교체합니다.예제

[root@rbd-client-site-b ~]# systemctl enable ceph-rbd-mirror.target [root@rbd-client-site-b ~]# systemctl enable ceph-rbd-mirror@rbd-mirror.site-a [root@rbd-client-site-b ~]# systemctl start ceph-rbd-mirror@rbd-mirror.site-a

중요각

rbd-mirror데몬에는 고유한 클라이언트 ID가 있어야 합니다.미러링 상태를 확인하려면

site-a및site-b클러스터의 Ceph Monitor 노드에서 다음 명령을 실행합니다.구문

rbd mirror image status POOL_NAME/IMAGE_NAME

예제

저널 기반 미러링:

[root@mon-site-a ~]# rbd mirror image status data/image1 image1: global_id: 08027096-d267-47f8-b52e-59de1353a034 state: up+stopped 1 description: local image is primary last_update: 2021-04-22 13:45:31스냅샷 기반 미러링:

[root@mon-site-a ~]# rbd mirror image status data/image1 image1: global_id: 47fd1aae-5f19-4193-a5df-562b5c644ea7 state: up+stopped 1 description: local image is primary service: admin on ceph-rbd1-vasi-43-5hwia4-node2 last_update: 2022-01-20 12:42:54 peer_sites: name: rbd-mirror.site-b state: up+replaying description: replaying, {"bytes_per_second":0.0,"bytes_per_snapshot":0.0,"local_snapshot_timestamp":1642693094,"remote_snapshot_timestamp":1642693094,"replay_state":"idle"} last_update: 2022-01-20 12:42:59 snapshots: 5 .mirror.primary.47fd1aae-5f19-4193-a5df-562b5c644ea7.dda146c6-5f21-4e75-ba93-660f6e57e301 (peer_uuids:[bfd09289-c9c9-40c8-b2d3-ead9b6a99a45])예제

저널 기반 미러링:

[root@mon-site-b ~]# rbd mirror image status data/image1 image1: global_id: 7d486c3f-d5a1-4bee-ae53-6c4f1e0c8eac state: up+replaying 1 description: replaying, master_position=[object_number=3, tag_tid=1, entry_tid=3], mirror_position=[object_number=3, tag_tid=1, entry_tid=3], entries_behind_master=0 last_update: 2021-04-22 14:19:27스냅샷 기반 미러링:

[root@mon-site-b ~]# rbd mirror image status data/image1 image1: global_id: 06acc9e6-a63d-4aa1-bd0d-4f3a79b0ae33 state: up+replaying 1 description: replaying, {"bytes_per_second":0.0,"bytes_per_snapshot":0.0,"local_snapshot_timestamp":1642689843,"remote_snapshot_timestamp":1642689843,"replay_state":"idle"} service: admin on ceph-rbd2-vasi-43-5hwia4-node2 last_update: 2022-01-20 12:41:57참고사이트 간 연결에 따라 미러링은 이미지를 동기화하는 데 시간이 오래 걸릴 수 있습니다.

추가 리소스

- 자세한 내용은 Red Hat Ceph Storage Block Device Guide의 Ceph 블록 장치 미러링 섹션을 참조하십시오.

- Ceph 사용자에 대한 자세한 내용은 Red Hat Ceph Storage 관리 가이드의 사용자 관리 섹션을 참조하십시오.

5.6. 명령줄 인터페이스를 사용하여 양방향 미러링 구성

다음 절차에서는 기본 스토리지 클러스터와 보조 스토리지 클러스터 간에 풀의 양방향 복제를 구성합니다.

양방향 복제를 사용하는 경우 두 스토리지 클러스터 간에만 미러링할 수 있습니다.

이 섹션의 예는 기본 이미지를 site-a 로 참조하며 이미지를 site-b 로 복제하는 보조 스토리지 클러스터를 참조하여 두 스토리지 클러스터를 구분합니다. 이 예제에서 사용되는 풀 이름을 data 라고 합니다.

사전 요구 사항

- Red Hat Ceph Storage 클러스터 최소 2개 이상 정상 및 실행 중인.

- 각 스토리지 클러스터의 Ceph 클라이언트 노드에 대한 루트 수준 액세스.

- 관리자 수준의 기능이 있는 CephX 사용자.

- 풀 내의 이미지에는 저널 기반 미러링에 사용할 수 있는 독점 잠금 및 저널링이 활성화되어 있어야 합니다.

절차

site-a스토리지 클러스터에 연결된 클라이언트 노드와site-b스토리지 클러스터에 연결된 클라이언트 노드에rbd-mirror패키지를 설치합니다.Red Hat Enterprise Linux 7

[root@rbd-client ~]# yum install rbd-mirror

Red Hat Enterprise Linux 8

[root@rbd-client ~]# dnf install rbd-mirror

참고패키지는 Red Hat Ceph Storage Tools 리포지토리에서 제공됩니다.

이미지에서 배타적 잠금 및 저널링 기능을 활성화합니다.

새 이미지 의 경우

--image-feature옵션을 사용합니다.구문

rbd create IMAGE_NAME --size MEGABYTES --pool POOL_NAME --image-feature FEATURE [,FEATURE]

예제

[root@rbd-client ~]# rbd create image1 --size 1024 --pool data --image-feature exclusive-lock,journaling

기존 이미지 의 경우

rbd 기능 enable 명령을사용합니다.구문

rbd feature enable POOL_NAME/IMAGE_NAME FEATURE [,FEATURE]

예제

[root@rbd-client ~]# rbd feature enable data/image1 exclusive-lock,journaling

기본적으로 모든 새 이미지에서 배타적 잠금 및 저널링을 활성화하려면 Ceph 구성 파일에 다음 설정을 추가합니다.

rbd_default_features = 125

미러링 모드(풀 또는 이미지 모드)를 선택합니다.

중요스냅샷 기반 미러링에 이미지 모드를 사용합니다.

풀 모드 활성화:

구문

rbd mirror pool enable POOL_NAME MODE

예제

[root@rbd-client ~]# rbd mirror pool enable data pool

이 예제에서는

data라는 전체 풀을 미러링할 수 있습니다.이미지 모드 활성화:

구문

rbd mirror pool enable POOL_NAME MODE

예제

[root@rbd-client ~]# rbd mirror pool enable data image

이 예제에서는

data라는 풀에서 이미지 모드 미러링을 활성화합니다.미러링이 성공적으로 활성화되었는지 확인합니다.

구문

rbd mirror pool info POOL_NAME예제

[root@rbd-client ~]# rbd mirror pool info data Mode: image Site Name: 94cbd9ca-7f9a-441a-ad4b-52a33f9b7148 Peer Sites: none

site-a클러스터에서 다음 단계를 완료합니다.Ceph 클라이언트 노드에서 사용자를 생성합니다.

구문

ceph auth get-or-create client.PRIMARY_CLUSTER_NAME mon 'profile rbd-mirror' osd 'profile rbd' -o /etc/ceph/ceph.PRIMARY_CLUSTER_NAME.keyring

예제

[root@rbd-client-site-a ~]# ceph auth get-or-create client.rbd-mirror.site-a mon 'profile rbd-mirror' osd 'profile rbd' -o /etc/ceph/ceph.client.rbd-mirror.site-a.keyring

인증 키를

site-b클러스터에 복사합니다.구문

scp /etc/ceph/ceph.PRIMARY_CLUSTER_NAME.keyring root@SECONDARY_CLUSTER:_PATH_

예제

[root@rbd-client-site-a ~]# scp /etc/ceph/ceph.client.rbd-mirror.site-a.keyring root@rbd-client-site-b:/etc/ceph/

Ceph 클라이언트 노드에서 스토리지 클러스터 피어를 부트스트랩합니다.

스토리지 클러스터 피어를 풀에 등록합니다.

구문

rbd mirror pool peer bootstrap create --site-name LOCAL_SITE_NAME POOL_NAME > PATH_TO_BOOTSTRAP_TOKEN

예제

[root@rbd-client-site-a ~]# rbd mirror pool peer bootstrap create --site-name rbd-mirror.site-a data > /root/bootstrap_token_rbd-mirror.site-a

참고이 예제 bootstrap 명령은

client.rbd-mirror-peerCeph 사용자를 생성합니다.부트스트랩 토큰 파일을

site-b스토리지 클러스터에 복사합니다.구문

scp PATH_TO_BOOTSTRAP_TOKEN root@SECONDARY_CLUSTER:/root/

예제

[root@rbd-client-site-a ~]# scp /root/bootstrap_token_site-a root@ceph-rbd2:/root/

site-b클러스터에서 다음 단계를 완료합니다.클라이언트 노드에서 사용자를 생성합니다.

구문

ceph auth get-or-create client.SECONDARY_CLUSTER_NAME mon 'profile rbd-mirror' osd 'profile rbd' -o /etc/ceph/ceph.SECONDARY_CLUSTER_NAME.keyring

예제

[root@rbd-client-site-b ~]# ceph auth get-or-create client.rbd-mirror.site-b mon 'profile rbd-mirror' osd 'profile rbd' -o /etc/ceph/ceph.client.rbd-mirror.site-b.keyring

인증 키를 Ceph 클라이언트 노드인

site-a클러스터에 복사합니다.구문

scp /etc/ceph/ceph.SECONDARY_CLUSTER_NAME.keyring root@PRIMARY_CLUSTER:_PATH_

예제

[root@rbd-client-site-b ~]# scp /etc/ceph/ceph.client.rbd-mirror.site-b.keyring root@rbd-client-site-a:/etc/ceph/

부트스트랩 토큰을 가져옵니다.

구문

rbd mirror pool peer bootstrap import --site-name LOCAL_SITE_NAME --direction rx-tx POOL_NAME PATH_TO_BOOTSTRAP_TOKEN

예제

[root@rbd-client-site-b ~]# rbd mirror pool peer bootstrap import --site-name rbd-mirror.site-b --direction rx-tx data /root/bootstrap_token_rbd-mirror.site-a

참고양방향 미러링은 피어를 부트 스트랩할 때 기본 설정이므로

--direction인수는 선택 사항입니다.

기본 및 보조 클라이언트 노드에서

rbd-mirror데몬을 활성화하고 시작합니다.구문

systemctl enable ceph-rbd-mirror.target systemctl enable ceph-rbd-mirror@rbd-mirror.CLIENT_ID systemctl start ceph-rbd-mirror@rbd-mirror.CLIENT_ID

CLIENT_ID를 이전에 만든 Ceph 사용자로 교체합니다.예제

[root@rbd-client-site-a ~]# systemctl enable ceph-rbd-mirror.target [root@rbd-client-site-a ~]# systemctl enable ceph-rbd-mirror@rbd-mirror.site-a [root@rbd-client-site-a ~]# systemctl start ceph-rbd-mirror@rbd-mirror.site-a [root@rbd-client-site-a ~]# systemctl enable ceph-rbd-mirror@rbd-mirror.site-b [root@rbd-client-site-a ~]# systemctl start ceph-rbd-mirror@rbd-mirror.site-b

위의 예에서 사용자는 기본 클러스터

사이트-a에서 사용하도록 설정되어 있습니다.예제

[root@rbd-client-site-b ~]# systemctl enable ceph-rbd-mirror.target [root@rbd-client-site-b ~]# systemctl enable ceph-rbd-mirror@rbd-mirror.site-a [root@rbd-client-site-b ~]# systemctl start ceph-rbd-mirror@rbd-mirror.site-a [root@rbd-client-site-b ~]# systemctl enable ceph-rbd-mirror@rbd-mirror.site-b [root@rbd-client-site-b ~]# systemctl start ceph-rbd-mirror@rbd-mirror.site-b

위의 예에서 사용자는 보조 클러스터

site-b에서 사용하도록 설정되어 있습니다.중요각

rbd-mirror데몬에는 고유한 클라이언트 ID가 있어야 합니다.미러링 상태를 확인하려면

site-a및site-b클러스터의 Ceph Monitor 노드에서 다음 명령을 실행합니다.구문

rbd mirror image status POOL_NAME/IMAGE_NAME

예제

저널 기반 미러링:

[root@mon-site-a ~]# rbd mirror image status data/image1 image1: global_id: 08027096-d267-47f8-b52e-59de1353a034 state: up+stopped 1 description: local image is primary last_update: 2021-04-22 13:45:31스냅샷 기반 미러링:

[root@mon-site-a ~]# rbd mirror image status data/image1 image1: global_id: 47fd1aae-5f19-4193-a5df-562b5c644ea7 state: up+stopped 1 description: local image is primary service: admin on ceph-rbd1-vasi-43-5hwia4-node2 last_update: 2022-01-20 12:42:54 peer_sites: name: rbd-mirror.site-b state: up+replaying description: replaying, {"bytes_per_second":0.0,"bytes_per_snapshot":0.0,"local_snapshot_timestamp":1642693094,"remote_snapshot_timestamp":1642693094,"replay_state":"idle"} last_update: 2022-01-20 12:42:59 snapshots: 5 .mirror.primary.47fd1aae-5f19-4193-a5df-562b5c644ea7.dda146c6-5f21-4e75-ba93-660f6e57e301 (peer_uuids:[bfd09289-c9c9-40c8-b2d3-ead9b6a99a45])예제

저널 기반 미러링:

[root@mon-site-b ~]# rbd mirror image status data/image1 image1: global_id: 7d486c3f-d5a1-4bee-ae53-6c4f1e0c8eac state: up+replaying 1 description: replaying, master_position=[object_number=3, tag_tid=1, entry_tid=3], mirror_position=[object_number=3, tag_tid=1, entry_tid=3], entries_behind_master=0 last_update: 2021-04-22 14:19:27스냅샷 기반 미러링:

[root@mon-site-b ~]# rbd mirror image status data/image1 image1: global_id: 06acc9e6-a63d-4aa1-bd0d-4f3a79b0ae33 state: up+replaying 1 description: replaying, {"bytes_per_second":0.0,"bytes_per_snapshot":0.0,"local_snapshot_timestamp":1642689843,"remote_snapshot_timestamp":1642689843,"replay_state":"idle"} service: admin on ceph-rbd2-vasi-43-5hwia4-node2 last_update: 2022-01-20 12:41:57참고사이트 간 연결에 따라 미러링은 이미지를 동기화하는 데 시간이 오래 걸릴 수 있습니다.

추가 리소스

- 자세한 내용은 Red Hat Ceph Storage Block Device Guide의 Ceph 블록 장치 미러링 섹션을 참조하십시오.

- Ceph 사용자에 대한 자세한 내용은 Red Hat Ceph Storage 관리 가이드의 사용자 관리 섹션을 참조하십시오.

5.7. Ceph 블록 장치 미러링을 위한 관리

스토리지 관리자는 Ceph 블록 장치 미러링 환경을 관리하는 데 도움이 되도록 다양한 작업을 수행할 수 있습니다. 다음 작업을 수행할 수 있습니다.

- 스토리지 클러스터 피어에 대한 정보 보기.

- 스토리지 클러스터 피어를 추가하거나 제거합니다.

- 풀 또는 이미지에 대한 미러링 상태 가져오기.

- 풀 또는 이미지에서 미러링 활성화

- 풀 또는 이미지에서 미러링 비활성화.

- 블록 장치 복제 지연.

- 이미지 승격 및 데모.

5.7.1. 사전 요구 사항

- 최소 2개의 정상 실행 Red Hat Ceph Storage 클러스터.

- Ceph 클라이언트 노드에 대한 루트 수준 액세스.

- 단방향 또는 양방향 Ceph 블록 장치 미러링 관계입니다.

5.7.2. 피어에 대한 정보 보기

스토리지 클러스터 피어에 대한 정보를 봅니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 노드에 대한 루트 수준 액세스.

절차

피어에 대한 정보를 보려면 다음을 수행합니다.

구문

rbd mirror pool info POOL_NAME예제

[root@rbd-client ~]# rbd mirror pool info data Mode: pool Site Name: site-a Peer Sites: UUID: 950ddadf-f995-47b7-9416-b9bb233f66e3 Name: site-b Mirror UUID: 4696cd9d-1466-4f98-a97a-3748b6b722b3 Direction: rx-tx Client: client.site-b

5.7.3. 풀에서 미러링 활성화

두 피어 클러스터에서 다음 명령을 실행하여 풀에서 미러링을 활성화합니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 노드에 대한 루트 수준 액세스.

절차

풀에서 미러링을 활성화하려면 다음을 수행합니다.

구문

rbd mirror pool enable POOL_NAME MODE

예제

[root@rbd-client ~]# rbd mirror pool enable data pool

이 예제에서는

data라는 전체 풀을 미러링할 수 있습니다.예제

[root@rbd-client ~]# rbd mirror pool enable data image

이 예제에서는

data라는 풀에서 이미지 모드 미러링을 활성화합니다.

추가 리소스

- 자세한 내용은 Red Hat Ceph Storage Block Device Guide의 Ceph 블록 장치 미러링 섹션을 참조하십시오.

5.7.4. 풀에서 미러링 비활성화

미러링을 비활성화하기 전에 피어 클러스터를 제거합니다.

풀에서 미러링을 비활성화할 때 이미지 모드에서 미러링이 별도로 활성화된 풀 내의 이미지에서도 이를 비활성화합니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 노드에 대한 루트 수준 액세스.

절차

풀에서 미러링을 비활성화하려면 다음을 수행합니다.

구문

rbd mirror pool disable POOL_NAME예제

[root@rbd-client ~]# rbd mirror pool disable data

이 예제에서는

data라는 풀의 미러링을 비활성화합니다.

추가 리소스

- 자세 한 내용은 Red Hat Ceph Storage Block Device Guide 의 이미지 단방향 미러링 섹션을 참조하십시오.

- 자세 한 내용은 Red Hat Ceph Storage Block Device Guide 의 스토리지 클러스터 피어 제거 섹션을 참조하십시오.

5.7.5. 이미지 미러링 활성화

두 피어 스토리지 클러스터에서 이미지 모드에서 전체 풀에서 미러링을 활성화합니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 노드에 대한 루트 수준 액세스.

절차

풀 내의 특정 이미지에 대한 미러링을 활성화합니다.

구문

rbd mirror image enable POOL_NAME/IMAGE_NAME

예제

[root@rbd-client ~]# rbd mirror image enable data/image2

이 예제에서는

데이터풀에서image2이미지에 대한 미러링을 활성화합니다.

추가 리소스

- 자세 한 내용은 Red Hat Ceph Storage Block Device Guide 의 pool에서 미러링 활성화 섹션을 참조하십시오.

5.7.6. 이미지 미러링 비활성화

이미지의 미러를 비활성화합니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 노드에 대한 루트 수준 액세스.

절차

특정 이미지에 대한 미러링을 비활성화하려면 다음을 수행합니다.

구문

rbd mirror image disable POOL_NAME/IMAGE_NAME

예제

[root@rbd-client ~]# rbd mirror image disable data/image2

이 예제에서는

데이터풀에서image2이미지 미러링을 비활성화합니다.

5.7.7. 이미지 승격 및 데모

이미지를 승격하거나 시연합니다.

승격 후 이미지가 유효하지 않으므로 계속 동기화되는 비기본 이미지를 강제로 승격하지 마십시오.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 노드에 대한 루트 수준 액세스.

절차

기본이 아닌 이미지를 시연하려면 다음을 수행하십시오.

구문

rbd mirror image demote POOL_NAME/IMAGE_NAME

예제

[root@rbd-client ~]# rbd mirror image demote data/image2

이 예제에서는

data풀에서image2이미지를 시연합니다.이미지를 primary로 승격하려면 다음을 수행하십시오.

구문

rbd mirror image promote POOL_NAME/IMAGE_NAME

예제

[root@rbd-client ~]# rbd mirror image promote data/image2

이 예제에서는

데이터풀에서image2를 승격합니다.사용 중인 미러링 유형에 따라 단계별 미러링이 있는 재해 복구 또는 양방향 미러링 이 있는 재해에서 복구를 참조하십시오.

--force옵션을 사용하여 기본이 아닌 이미지를 강제로 승격합니다.구문

rbd mirror image promote --force POOL_NAME/IMAGE_NAME

예제

[root@rbd-client ~]# rbd mirror image promote --force data/image2

데모를 피어 Ceph 스토리지 클러스터로 전파할 수 없는 경우 강제 승격을 사용합니다. 예를 들어 클러스터 오류 또는 통신 중단으로 인해.

추가 리소스

5.7.8. 이미지 재동기화

이미지를 다시 동기화합니다. 두 피어 클러스터 간에 일관성 없는 상태의 경우 rbd-mirror 데몬은 불일치를 유발하는 이미지를 미러링하지 않습니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 노드에 대한 루트 수준 액세스.

절차

기본 이미지로 재동기화를 요청하려면 다음을 수행합니다.

구문

rbd mirror image resync POOL_NAME/IMAGE_NAME

예제

[root@rbd-client ~]# rbd mirror image resync data/image2

이 예제에서는

데이터풀에서image2의 resynchronization을 요청합니다.

추가 리소스

- 재해로 인해 일관성 없는 상태에서 복구하려면 단방향 미러링 을 통해 재해 복구 또는 자세한 내용은 양방향 미러링 을 통해 재해에서 복구를 참조하십시오.

5.7.9. 스토리지 클러스터 피어 추가

rbd-mirror 데몬의 스토리지 클러스터 피어를 추가하여 피어 스토리지 클러스터를 검색합니다. 예를 들어 site-a 스토리지 클러스터를 site-b 스토리지 클러스터에 피어로 추가하려면 site-b 스토리지 클러스터의 클라이언트 노드에서 다음 절차를 따르십시오.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 노드에 대한 루트 수준 액세스.

절차

피어를 풀에 등록합니다.

구문

rbd --cluster CLUSTER_NAME mirror pool peer add POOL_NAME PEER_CLIENT_NAME@PEER_CLUSTER_NAME -n CLIENT_NAME

예제

[root@rbd-client ~]# rbd --cluster site-b mirror pool peer add data client.site-a@site-a -n client.site-b

5.7.10. 스토리지 클러스터 피어 제거

피어 UUID를 지정하여 스토리지 클러스터 피어를 제거합니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 노드에 대한 루트 수준 액세스.

절차

풀 이름과 UUID(Universally Unique Identifier)를 지정합니다.

구문

rbd mirror pool peer remove POOL_NAME PEER_UUID

예제

[root@rbd-client ~]# rbd mirror pool peer remove data 7e90b4ce-e36d-4f07-8cbc-42050896825d

작은 정보피어 UUID를 보려면

rbd 미러 pool info명령을 사용합니다.

5.7.11. 풀의 미러링 상태 가져오기

풀의 미러 상태를 가져옵니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 노드에 대한 루트 수준 액세스.

절차

미러링 풀 요약을 가져오려면 다음을 수행합니다.

구문

rbd mirror pool status POOL_NAME예제

[root@rbd-client ~]# rbd mirror pool status data health: OK images: 1 total

작은 정보풀의 모든 미러링 이미지에 대한 상태 세부 정보를 출력하려면

--verbose옵션을 사용합니다.

5.7.12. 단일 이미지에 대한 미러링 상태 가져오기

이미지의 미러 상태를 가져옵니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 노드에 대한 루트 수준 액세스.

절차

미러링된 이미지의 상태를 가져오려면 다음을 수행합니다.

구문

rbd mirror image status POOL_NAME/IMAGE_NAME

예제

[root@rbd-client ~]# rbd mirror image status data/image2 image2: global_id: 703c4082-100d-44be-a54a-52e6052435a5 state: up+replaying description: replaying, master_position=[object_number=0, tag_tid=3, entry_tid=0], mirror_position=[object_number=0, tag_tid=3, entry_tid=0], entries_behind_master=0 last_update: 2019-04-23 13:39:15

이 예제에서는

데이터풀에서image2이미지의 상태를 가져옵니다.

5.7.13. 블록 장치 복제 지연

one- 또는 양방향 복제를 사용하는 경우 RADOS Block Device(RBD) 미러링 이미지 간 복제를 지연할 수 있습니다. 원하지 않는 변경을 주 이미지로 변경하면 보조 이미지로 복제되기 전에 지연된 복제를 구현해야 하는 경우 지연된 복제를 구현할 수 있습니다.

지연된 복제를 구현하려면 대상 스토리지 클러스터 내의 rbd-mirror 데몬에서 rbd_mirroring_replay_delay = MINIMUM_DELAY_IN_SECONDS 구성 옵션을 설정해야 합니다. 이 설정은 rbd-mirror 데몬이나 개별 이미지 기반으로 사용하는 ceph.conf 파일 내에서 전역으로 적용할 수 있습니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 노드에 대한 루트 수준 액세스.

절차

지연된 복제를 특정 이미지에 활용하려면 기본 이미지에서 다음

rbdCLI 명령을 실행합니다.구문

rbd image-meta set POOL_NAME/IMAGE_NAME conf_rbd_mirroring_replay_delay MINIMUM_DELAY_IN_SECONDS

예제

[root@rbd-client ~]# rbd image-meta set vms/vm-1 conf_rbd_mirroring_replay_delay 600

이 예제에서는 vms 풀의 이미지

vm-1에서 10분의 최소 복제 지연을설정합니다.

5.7.14. 비동기 업데이트 및 Ceph 블록 장치 미러링

비동기 업데이트로 Ceph 블록 장치 미러링을 사용하여 스토리지 클러스터를 업데이트할 때 Red Hat Ceph Storage 설치 가이드 의 업데이트 지침을 따르십시오. 업데이트가 완료되면 Ceph 블록 장치 인스턴스를 다시 시작합니다.

인스턴스를 재시작하는 데 필요한 순서가 없습니다. Red Hat은 기본 이미지 다음에 미러링된 풀을 가리키는 인스턴스를 재시작하는 것이 좋습니다.

5.7.15. 이미지 mirror-snapshot 생성

스냅샷 기반 미러링을 사용할 때 RBD 이미지의 변경된 내용을 미러링해야 하는 경우 이미지 mirror-snapshot을 만듭니다.

사전 요구 사항

- 최소 2개의 정상 실행 중인 Red Hat Ceph Storage 클러스터.

- Red Hat Ceph Storage 클러스터의 Ceph 클라이언트 노드에 대한 루트 수준 액세스.

- 관리자 수준의 기능이 있는 CephX 사용자.

- 스냅샷 미러가 생성되는 Red Hat Ceph Storage 클러스터에 액세스합니다.

기본적으로 이미지당 3개의 이미지 mirror-snapshots만 생성할 수 있습니다. 제한에 도달하면 최신 이미지 mirror-snapshot이 자동으로 제거됩니다. 필요한 경우 이 제한은 rbd_mirroring_max_mirroring_snapshots 구성을 통해 재정의할 수 있습니다. 이미지를 제거하거나 미러링이 비활성화된 경우 이미지 mirror-snapshots는 자동으로 삭제됩니다.

절차

image-mirror 스냅샷을 생성하려면 다음을 수행합니다.

구문

rbd --cluster CLUSTER_NAME mirror image snapshot POOL_NAME/IMAGE_NAME

예제

root@rbd-client ~]# rbd --cluster site-a mirror image snapshot data/image1

추가 리소스

- 자세한 내용은 Red Hat Ceph Storage Block Device Guide의 Ceph 블록 장치 미러링 섹션을 참조하십시오.

5.7.16. mirror-snapshots 예약

mirror-snapshots는 mirror-snapshot schedules가 정의되면 자동으로 생성될 수 있습니다. mirror-snapshot은 전역, 풀당 또는 이미지 수준까지 예약할 수 있습니다. 여러 mirror-snapshot 일정은 모든 수준에서 정의할 수 있지만 미러링된 개별 이미지와 일치하는 가장 구체적인 스냅샷 일정만 실행할 수 있습니다.

추가 리소스

- 자세한 내용은 Red Hat Ceph Storage Block Device Guide의 Ceph 블록 장치 미러링 섹션을 참조하십시오.

5.7.17. mirror-snapshot 일정 생성

mirror-snapshot 일정을 생성합니다.

사전 요구 사항

- 최소 2개의 정상 실행 중인 Red Hat Ceph Storage 클러스터.

- Red Hat Ceph Storage 클러스터의 Ceph 클라이언트 노드에 대한 루트 수준 액세스.

- 관리자 수준의 기능이 있는 CephX 사용자.

- 스냅샷 미러가 생성되는 Red Hat Ceph Storage 클러스터에 액세스합니다.

절차

mirror-snapshot 일정을 생성하려면 다음을 수행합니다.

구문

rbd mirror snapshot schedule add --pool POOL_NAME --image IMAGE_NAME INTERVAL START_TIME

간격은 각각 d, h 또는 m 접미사를 사용하여 일, 시간 또는 분 단위로 지정할 수 있습니다. 선택적 START_TIME은 ISO 8601 시간 형식을 사용하여 지정할 수 있습니다.

예제

이미지 수준에서 예약:

[root@rbd-client ~]# rbd mirror snapshot schedule add --pool data --image image1 6h

풀 수준에서 예약:

[root@rbd-client ~]# rbd mirror snapshot schedule add --pool data 24h 14:00:00-05:00

글로벌 수준의 예약:

[root@rbd-client ~]# rbd mirror snapshot schedule add 48h

추가 리소스

- 자세한 내용은 Red Hat Ceph Storage Block Device Guide의 Ceph 블록 장치 미러링 섹션을 참조하십시오.

5.7.18. 특정 수준에서 모든 스냅샷 일정 나열

특정 수준의 모든 스냅샷 일정을 나열합니다.

사전 요구 사항

- 최소 2개의 정상 실행 중인 Red Hat Ceph Storage 클러스터.

- Red Hat Ceph Storage 클러스터의 Ceph 클라이언트 노드에 대한 루트 수준 액세스.

- 관리자 수준의 기능이 있는 CephX 사용자.

- 스냅샷 미러가 생성되는 Red Hat Ceph Storage 클러스터에 액세스합니다.

절차

선택적 풀 또는 이미지 이름을 사용하여 특정 글로벌, 풀 또는 이미지 수준에 대한 모든 스냅샷 일정을 나열하려면 다음을 수행합니다.

구문

rbd --cluster site-a mirror snapshot schedule ls --pool POOL_NAME --recursive또한 '-

recursive옵션을 지정하여 다음과 같이 지정된 수준에서 모든 일정을 나열할 수 있습니다.예제

[root@rbd-client ~]# rbd --cluster site-a mirror snapshot schedule ls --pool data --recursive POOL NAMESPACE IMAGE SCHEDULE data - - every 1d starting at 14:00:00-05:00 data - image1 every 6h

추가 리소스

- 자세한 내용은 Red Hat Ceph Storage Block Device Guide의 Ceph 블록 장치 미러링 섹션을 참조하십시오.

5.7.19. mirror-snapshot 일정 제거

mirror-snapshot 일정을 제거합니다.

사전 요구 사항

- 최소 2개의 정상 실행 중인 Red Hat Ceph Storage 클러스터.

- Red Hat Ceph Storage 클러스터의 Ceph 클라이언트 노드에 대한 루트 수준 액세스.

- 관리자 수준의 기능이 있는 CephX 사용자.

- 스냅샷 미러가 생성되는 Red Hat Ceph Storage 클러스터에 액세스합니다.

절차

mirror-snapshot 일정을 제거하려면 다음을 수행합니다.

구문

rbd --cluster CLUSTER_NAME mirror snapshot schedule remove POOL_NAME/IMAGE_NAME INTERVAL START_TIME

d, h, m 접미사를 각각 사용하여 간격을 일, 시간 또는 분 단위로 지정할 수 있습니다. 선택적 START_TIME은 ISO 8601 시간 형식을 사용하여 지정할 수 있습니다.

예제

[root@rbd-client ~]# rbd --cluster site-a mirror snapshot schedule remove data/image1 6h

예제

[root@rbd-client ~]# rbd --cluster site-a mirror snapshot schedule remove data/image1 24h 14:00:00-05:00

추가 리소스

- 자세한 내용은 Red Hat Ceph Storage Block Device Guide의 Ceph 블록 장치 미러링 섹션을 참조하십시오.

5.7.20. 생성할 다음 스냅샷의 상태 보기

스냅샷 기반 미러링 RBD 이미지에 대해 생성할 다음 스냅샷의 상태를 확인합니다.

사전 요구 사항

- 최소 2개의 정상 실행 중인 Red Hat Ceph Storage 클러스터.

- Red Hat Ceph Storage 클러스터의 Ceph 클라이언트 노드에 대한 루트 수준 액세스.

- 관리자 수준의 기능이 있는 CephX 사용자.

- 스냅샷 미러가 생성되는 Red Hat Ceph Storage 클러스터에 액세스합니다.

절차

생성할 다음 스냅샷의 상태를 보려면 다음을 수행합니다.

구문

rbd --cluster site-a mirror snapshot schedule status POOL_NAME/IMAGE_NAME