CLI 툴

OpenShift Container Platform 명령줄 툴 사용 방법 알아보기

초록

1장. OpenShift Container Platform CLI 툴 개요

사용자는 다음과 같은 OpenShift Container Platform에서 작업하는 동안 다양한 작업을 수행합니다.

- 클러스터 관리

- 애플리케이션 구축, 배포 및 관리

- 배포 프로세스 관리

- Operator 개발

- Operator 카탈로그 생성 및 유지 관리

OpenShift Container Platform은 사용자가 터미널에서 다양한 관리 및 개발 작업을 수행할 수 있도록 하여 이러한 작업을 간소화하는 CLI(명령줄 인터페이스) 툴 세트를 제공합니다. 이러한 툴을 사용하면 간단한 명령을 사용하여 애플리케이션을 관리할 수 있을 뿐 아니라 시스템의 각 구성 요소와 상호 작용할 수 있습니다.

1.1. CLI 툴 목록

OpenShift Container Platform에서는 다음 CLI 툴 세트를 사용할 수 있습니다.

- OpenShift CLI (oc): OpenShift Container Platform 사용자가 가장 일반적으로 사용하는 CLI 툴입니다. 클러스터 관리자와 개발자가 터미널을 사용하여 OpenShift Container Platform에서 포괄적인 작업을 수행할 수 있습니다. 웹 콘솔과 달리 사용자는 명령 스크립트를 사용하여 프로젝트 소스 코드와 직접 작업할 수 있습니다.

-

개발자 CLI (odo):

odoCLI 툴을 사용하면 개발자가 복잡한 Kubernetes 및 OpenShift Container Platform 개념을 추상화하여 OpenShift Container Platform에서 애플리케이션을 생성하고 유지 관리하는 기본 목표에 집중할 수 있습니다. 개발자가 클러스터를 관리할 필요 없이 터미널에서 클러스터에서 애플리케이션을 작성, 빌드 및 디버깅할 수 있습니다. -

Knative CLI(kn): Knative(

kn) CLI 툴은 Knative Serving 및 Eventing과 같은 OpenShift Serverless 구성 요소와 상호 작용하는 데 사용할 수 있는 간단하고 직관적인 터미널 명령을 제공합니다. -

Pipeline CLI(tkn): OpenShift Pipelines는 OpenShift Container Platform의 CI/CD(지속적 통합 및 연속 제공) 솔루션으로, 내부적으로 Tekton을 사용합니다.

tknCLI 툴은 터미널을 사용하여 OpenShift Pipelines와 상호 작용할 수 있는 간단하고 직관적인 명령을 제공합니다. -

opm CLI:

opmCLI 툴을 사용하면 Operator 개발자와 클러스터 관리자가 터미널에서 Operator 카탈로그를 생성하고 유지 관리할 수 있습니다. - Operator SDK: Operator 프레임워크의 구성 요소인 Operator SDK는 Operator 개발자가 터미널에서 Operator를 빌드, 테스트 및 배포하는 데 사용할 수 있는 CLI 툴을 제공합니다. Kubernetes 네이티브 애플리케이션을 구축하는 프로세스를 간소화하며, 이를 위해서는 애플리케이션별 운영 지식이 필요할 수 있습니다.

2장. OpenShift CLI(oc)

2.1. OpenShift CLI 시작하기

2.1.1. OpenShift CLI 정보

OpenShift CLI(명령줄 인터페이스) 즉, oc 명령을 사용하면 터미널에서 애플리케이션을 생성하고 OpenShift Container Platform 프로젝트를 관리할 수 있습니다. OpenShift CLI를 사용하기에 적합한 경우는 다음과 같습니다.

- 직접 프로젝트 소스 코드로 작업하는 경우

- OpenShift Container Platform 작업 스크립트를 작성하는 경우

- 대역폭 리소스가 제한되고 웹 콘솔을 사용할 수 없는 상태에서 프로젝트를 관리하는 경우

2.1.2. OpenShift CLI 설치

OpenShift CLI(oc)는 바이너리를 다운로드하거나 RPM을 사용하여 설치할 수 있습니다.

2.1.2.1. 바이너리를 다운로드하여 OpenShift CLI 설치

명령줄 인터페이스를 사용하여 OpenShift Container Platform과 상호 작용하기 위해 OpenShift CLI(oc)를 설치할 수 있습니다. Linux, Windows 또는 macOS에 oc를 설치할 수 있습니다.

이전 버전의 oc를 설치한 경우, OpenShift Container Platform 4.8의 모든 명령을 완료하는 데 해당 버전을 사용할 수 없습니다. 새 버전의 oc를 다운로드하여 설치합니다.

Linux에서 OpenShift CLI 설치

다음 절차를 사용하여 Linux에서 OpenShift CLI(oc) 바이너리를 설치할 수 있습니다.

프로세스

- Red Hat 고객 포털에서 OpenShift Container Platform 다운로드 페이지로 이동합니다.

- 버전 드롭다운 메뉴에서 적절한 버전을 선택합니다.

- OpenShift v4.8 Linux Client 항목 옆에 있는 지금 다운로드를 클릭하고 파일을 저장합니다.

아카이브의 압축을 풉니다.

$ tar xvzf <file>

oc바이너리를PATH에 있는 디렉터리에 배치합니다.PATH를 확인하려면 다음 명령을 실행합니다.$ echo $PATH

OpenShift CLI를 설치한 후 oc 명령을 사용할 수 있습니다.

$ oc <command>

Windows에서 OpenSfhit CLI 설치

다음 절차에 따라 Windows에 OpenShift CLI(oc) 바이너리를 설치할 수 있습니다.

프로세스

- Red Hat 고객 포털에서 OpenShift Container Platform 다운로드 페이지로 이동합니다.

- 버전 드롭다운 메뉴에서 적절한 버전을 선택합니다.

- OpenShift v4.8 Windows Client 항목 옆에 있는 지금 다운로드를 클릭하고 파일을 저장합니다.

- ZIP 프로그램으로 아카이브의 압축을 풉니다.

oc바이너리를PATH에 있는 디렉터리로 이동합니다.PATH를 확인하려면 명령 프롬프트를 열고 다음 명령을 실행합니다.C:\> path

OpenShift CLI를 설치한 후 oc 명령을 사용할 수 있습니다.

C:\> oc <command>

macOS에 OpenShift CLI 설치

다음 절차에 따라 macOS에서 OpenShift CLI(oc) 바이너리를 설치할 수 있습니다.

프로세스

- Red Hat 고객 포털에서 OpenShift Container Platform 다운로드 페이지로 이동합니다.

- 버전 드롭다운 메뉴에서 적절한 버전을 선택합니다.

- OpenShift v4.8 MacOSX Client 항목 옆에 있는 지금 다운로드를 클릭하고 파일을 저장합니다.

- 아카이브의 압축을 해제하고 압축을 풉니다.

oc바이너리 PATH의 디렉터리로 이동합니다.PATH를 확인하려면 터미널을 열고 다음 명령을 실행합니다.$ echo $PATH

OpenShift CLI를 설치한 후 oc 명령을 사용할 수 있습니다.

$ oc <command>

2.1.2.2. 웹 콘솔을 사용하여 OpenShift CLI 설치

웹 콘솔에서 OpenShift Container Platform과 상호 작용하기 위해 OpenShift CLI(oc)를 설치할 수 있습니다. Linux, Windows 또는 macOS에 oc를 설치할 수 있습니다.

이전 버전의 oc를 설치한 경우, OpenShift Container Platform 4.8의 모든 명령을 완료하는 데 해당 버전을 사용할 수 없습니다. 새 버전의 oc를 다운로드하여 설치합니다.

2.1.2.2.1. 웹 콘솔을 사용하여 Linux에 OpenShift CLI 설치

다음 절차를 사용하여 Linux에서 OpenShift CLI(oc) 바이너리를 설치할 수 있습니다.

절차

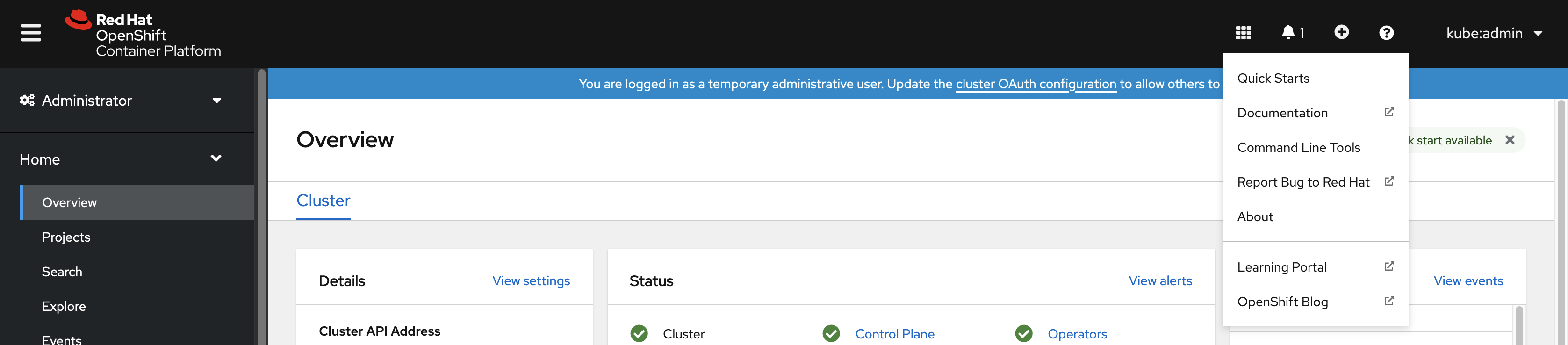

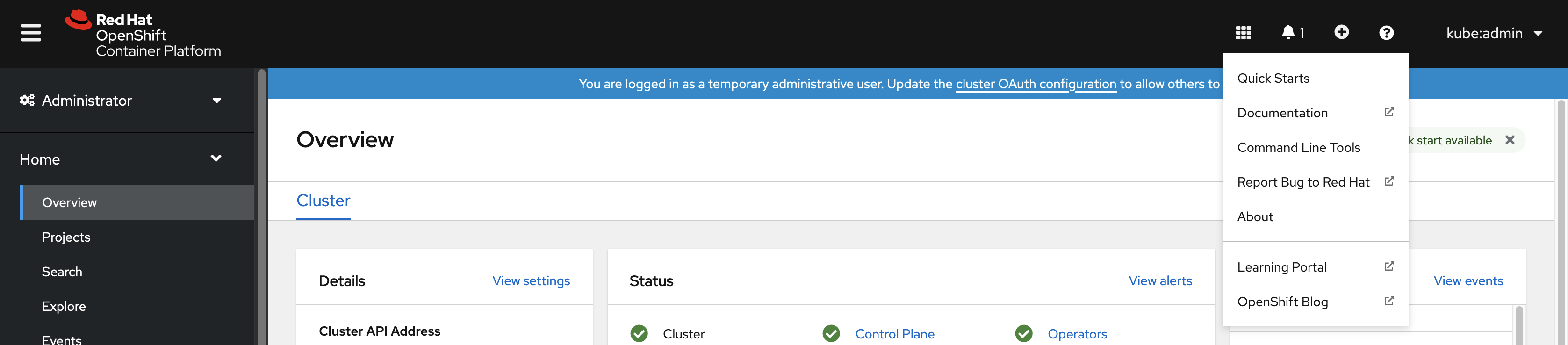

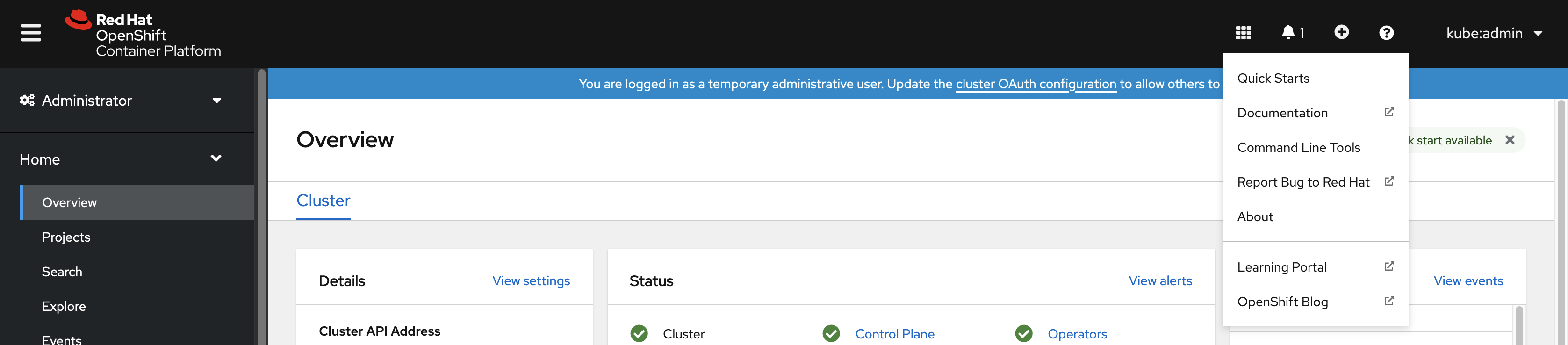

웹 콘솔에서 ? 를 클릭합니다.

명령줄 툴 을 클릭합니다.

-

Linux 플랫폼에 적합한

oc바이너리를 선택한 다음 Download oc for Linux(Linux 용 oc 다운로드)를 클릭합니다. - 파일을 저장합니다.

아카이브의 압축을 풉니다.

$ tar xvzf <file>

oc바이너리를PATH에 있는 디렉터리로 이동합니다.PATH를 확인하려면 다음 명령을 실행합니다.$ echo $PATH

OpenShift CLI를 설치한 후 oc 명령을 사용할 수 있습니다.

$ oc <command>

2.1.2.2.2. 웹 콘솔을 사용하여 Windows에서 OpenShift CLI 설치

다음 절차를 사용하여 Winndows에 OpenShift CLI(oc) 바이너리를 설치할 수 있습니다.

절차

웹 콘솔에서 ? 를 클릭합니다.

명령줄 툴 을 클릭합니다.

-

Windows용

oc바이너리를 선택한 다음 x86_64용 Windows용 oc 다운로드를 클릭합니다. - 파일을 저장합니다.

- ZIP 프로그램으로 아카이브의 압축을 풉니다.

oc바이너리를PATH에 있는 디렉터리로 이동합니다.PATH를 확인하려면 명령 프롬프트를 열고 다음 명령을 실행합니다.C:\> path

OpenShift CLI를 설치한 후 oc 명령을 사용할 수 있습니다.

C:\> oc <command>

2.1.2.2.3. 웹 콘솔을 사용하여 macOS에 OpenShift CLI 설치

다음 절차에 따라 macOS에서 OpenShift CLI(oc) 바이너리를 설치할 수 있습니다.

절차

웹 콘솔에서 ? 를 클릭합니다.

명령줄 툴 을 클릭합니다.

-

macOS용

oc바이너리를 선택한 다음 x86_64용 Mac용 oc 다운로드를 클릭합니다. - 파일을 저장합니다.

- 아카이브의 압축을 해제하고 압축을 풉니다.

oc바이너리 PATH의 디렉터리로 이동합니다.PATH를 확인하려면 터미널을 열고 다음 명령을 실행합니다.$ echo $PATH

OpenShift CLI를 설치한 후 oc 명령을 사용할 수 있습니다.

$ oc <command>

2.1.2.3. RPM을 사용하여 OpenShift CLI 설치

RHEL(Red Hat Enterprise Linux)의 경우 Red Hat 계정에 활성 OpenShift Container Platform 서브스크립션이 있으면 OpenShift CLI(oc)를 RPM으로 설치할 수 있습니다.

사전 요구 사항

- root 또는 sudo 권한이 있어야 합니다.

절차

Red Hat Subscription Manager에 등록합니다.

# subscription-manager register

최신 서브스크립션 데이터를 가져옵니다.

# subscription-manager refresh

사용 가능한 서브스크립션을 나열하십시오.

# subscription-manager list --available --matches '*OpenShift*'

이전 명령의 출력에서 OpenShift Container Platform 서브스크립션의 풀 ID를 찾아서 이 서브스크립션을 등록된 시스템에 연결합니다.

# subscription-manager attach --pool=<pool_id>

OpenShift Container Platform 4.8에 필요한 리포지터리를 활성화합니다.

Red Hat Enterprise Linux 8의 경우:

# subscription-manager repos --enable="rhocp-4.8-for-rhel-8-x86_64-rpms"

Red Hat Enterprise Linux 7의 경우:

# subscription-manager repos --enable="rhel-7-server-ose-4.8-rpms"

openshift-clients패키지를 설치합니다.# yum install openshift-clients

CLI를 설치한 후 oc 명령을 사용할 수 있습니다.

$ oc <command>

2.1.2.4. Homebrew를 사용하여 OpenShift CLI 설치

macOS의 경우 Homebrew 패키지 관리자를 사용하여 OpenShift CLI(oc)를 설치할 수 있습니다.

사전 요구 사항

-

Homebrew(

brew)가 설치되어 있어야 합니다.

절차

다음 명령을 실행하여 openshift-cli 패키지를 설치합니다.

$ brew install openshift-cli

2.1.3. OpenShift CLI에 로그인

OpenShift CLI (oc) 에 로그인하면 클러스터에 액세스하여 관리할 수 있습니다.

사전 요구 사항

- OpenShift Container Platform 클러스터에 대한 액세스 권한이 있어야 합니다.

-

OpenShift CLI(

oc)가 설치되어 있어야 합니다.

HTTP 프록시 서버를 통해서만 액세스할 수 있는 클러스터에 액세스하려면 HTTP_PROXY, HTTPS_PROXY 및 NO_PROXY 변수를 설정할 수 있습니다. oc CLI에서는 이러한 환경 변수를 준수하므로 클러스터와의 모든 통신이 HTTP 프록시를 통해 이루어집니다.

인증 헤더는 HTTPS 전송을 사용하는 경우에만 전송됩니다.

절차

oc login명령을 입력하고 사용자 이름을 전달합니다.$ oc login -u user1

프롬프트가 표시되면 필요한 정보를 입력합니다.

출력 예

Server [https://localhost:8443]: https://openshift.example.com:6443 1 The server uses a certificate signed by an unknown authority. You can bypass the certificate check, but any data you send to the server could be intercepted by others. Use insecure connections? (y/n): y 2 Authentication required for https://openshift.example.com:6443 (openshift) Username: user1 Password: 3 Login successful. You don't have any projects. You can try to create a new project, by running oc new-project <projectname> Welcome! See 'oc help' to get started.

웹 콘솔에 로그인한 경우 토큰 및 서버 정보를 포함하는 oc login 명령을 생성할 수 있습니다. 명령을 사용하여 대화형 프롬프트 없이 OpenShift Container Platform CLI에 로그인할 수 있습니다. 명령을 생성하려면 웹 콘솔의 오른쪽 상단에 있는 사용자 이름 드롭다운 메뉴에서 로그인 복사 명령을 선택합니다.

이제 클러스터를 관리하기 위한 프로젝트를 생성하거나 다른 명령을 실행할 수 있습니다.

2.1.4. OpenShift CLI 사용

다음 섹션을 검토하여 CLI로 일반적인 작업을 완료하는 방법을 알아봅니다.

2.1.4.1. 프로젝트 생성

oc new-project 명령을 사용하여 새 프로젝트를 생성합니다.

$ oc new-project my-project

출력 예

Now using project "my-project" on server "https://openshift.example.com:6443".

2.1.4.2. 새 애플리케이션 생성

oc new-app 명령을 사용하여 새 애플리케이션을 생성합니다.

$ oc new-app https://github.com/sclorg/cakephp-ex

출력 예

--> Found image 40de956 (9 days old) in imagestream "openshift/php" under tag "7.2" for "php"

...

Run 'oc status' to view your app.

2.1.4.3. Pod 보기

oc get pods 명령을 사용하여 현재 프로젝트의 Pod를 봅니다.

Pod 내부에서 oc 를 실행하고 네임스페이스를 지정하지 않으면 기본적으로 Pod의 네임스페이스가 사용됩니다.

$ oc get pods -o wide

출력 예

NAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE cakephp-ex-1-build 0/1 Completed 0 5m45s 10.131.0.10 ip-10-0-141-74.ec2.internal <none> cakephp-ex-1-deploy 0/1 Completed 0 3m44s 10.129.2.9 ip-10-0-147-65.ec2.internal <none> cakephp-ex-1-ktz97 1/1 Running 0 3m33s 10.128.2.11 ip-10-0-168-105.ec2.internal <none>

2.1.4.4. Pod 로그 보기

oc logs 명령을 사용하여 특정 Pod의 로그를 봅니다.

$ oc logs cakephp-ex-1-deploy

출력 예

--> Scaling cakephp-ex-1 to 1 --> Success

2.1.4.5. 현재 프로젝트 보기

oc project 명령을 사용하여 현재 프로젝트를 봅니다.

$ oc project

출력 예

Using project "my-project" on server "https://openshift.example.com:6443".

2.1.4.6. 현재 프로젝트의 상태 보기

oc status 명령을 사용하여 서비스, 배포, 빌드 구성 등 현재 프로젝트에 대한 정보를 봅니다.

$ oc status

출력 예

In project my-project on server https://openshift.example.com:6443

svc/cakephp-ex - 172.30.236.80 ports 8080, 8443

dc/cakephp-ex deploys istag/cakephp-ex:latest <-

bc/cakephp-ex source builds https://github.com/sclorg/cakephp-ex on openshift/php:7.2

deployment #1 deployed 2 minutes ago - 1 pod

3 infos identified, use 'oc status --suggest' to see details.

2.1.4.7. 지원되는 API 리소스 나열

oc api-resources 명령을 사용하여 서버에서 지원되는 API 리소스 목록을 봅니다.

$ oc api-resources

출력 예

NAME SHORTNAMES APIGROUP NAMESPACED KIND bindings true Binding componentstatuses cs false ComponentStatus configmaps cm true ConfigMap ...

2.1.5. 도움말 가져오기

CLI 명령 및 OpenShift Container Platform 리소스에 대한 도움말을 가져올 수 있는 방법은 다음과 같습니다.

oc help를 사용하여 모든 사용 가능한 CLI 명령 목록 및 설명을 가져옵니다.예제: CLI에 대한 일반적인 도움말 가져오기

$ oc help

출력 예

OpenShift Client This client helps you develop, build, deploy, and run your applications on any OpenShift or Kubernetes compatible platform. It also includes the administrative commands for managing a cluster under the 'adm' subcommand. Usage: oc [flags] Basic Commands: login Log in to a server new-project Request a new project new-app Create a new application ...

--help플래그를 사용하여 특정 CLI 명령에 대한 도움말을 가져옵니다.예제:

oc create명령에 대한 도움말 가져오기$ oc create --help

출력 예

Create a resource by filename or stdin JSON and YAML formats are accepted. Usage: oc create -f FILENAME [flags] ...

oc explain명령을 사용하여 특정 리소스에 대한 설명 및 필드를 봅니다.예제:

Pod리소스에 대한 문서 보기$ oc explain pods

출력 예

KIND: Pod VERSION: v1 DESCRIPTION: Pod is a collection of containers that can run on a host. This resource is created by clients and scheduled onto hosts. FIELDS: apiVersion <string> APIVersion defines the versioned schema of this representation of an object. Servers should convert recognized schemas to the latest internal value, and may reject unrecognized values. More info: https://git.k8s.io/community/contributors/devel/api-conventions.md#resources ...

2.1.6. OpenShift CLI에서 로그아웃

OpenShift CLI에서 로그아웃하여 현재 세션을 종료할 수 있습니다.

oc logout명령을 사용합니다.$ oc logout

출력 예

Logged "user1" out on "https://openshift.example.com"

이렇게 하면 저장된 인증 토큰이 서버에서 삭제되고 구성 파일에서 제거됩니다.

2.2. OpenShift CLI 구성

2.2.1. 탭 완료 활성화

Bash 또는 Zsh 쉘의 탭 완료를 활성화할 수 있습니다.

2.2.1.1. Bash의 탭 완료 활성화

OpenShift CLI(oc)를 설치한 후 탭 완료를 활성화하여 oc 명령을 자동으로 완료하거나 탭을 누를 때 옵션을 제안할 수 있습니다. 다음 절차에서는 Bash 쉘에 대한 탭 완료를 활성화합니다.

사전 요구 사항

-

OpenShift CLI(

oc)가 설치되어 있어야 합니다. -

bash-completion패키지가 설치되어 있어야 합니다.

절차

Bash 완료 코드를 파일에 저장합니다.

$ oc completion bash > oc_bash_completion

파일을

/etc/bash_completion.d/에 복사합니다.$ sudo cp oc_bash_completion /etc/bash_completion.d/

파일을 로컬 디렉터리에 저장하고

.bashrc파일에서 소싱할 수도 있습니다.

새 터미널을 열면 탭 완료가 활성화됩니다.

2.2.1.2. Zsh에 대한 탭 완료 활성화

OpenShift CLI(oc)를 설치한 후 탭 완료를 활성화하여 oc 명령을 자동으로 완료하거나 탭을 누를 때 옵션을 제안할 수 있습니다. 다음 절차에서는 Zsh 쉘에 대한 탭 완료를 활성화합니다.

사전 요구 사항

-

OpenShift CLI(

oc)가 설치되어 있어야 합니다.

절차

oc에 대한 탭 완료를.zshrc파일에 추가하려면 다음 명령을 실행합니다.$ cat >>~/.zshrc<<EOF if [ $commands[oc] ]; then source <(oc completion zsh) compdef _oc oc fi EOF

새 터미널을 열면 탭 완료가 활성화됩니다.

2.3. CLI 프로필 관리

CLI 구성 파일을 사용하면 CLI 툴 개요 와 함께 사용할 다양한 프로필 또는 컨텍스트를 구성할 수 있습니다. 컨텍스트는 nickname 과 관련된 사용자 인증 및 OpenShift Container Platform 서버 정보로 구성됩니다.

2.3.1. CLI 프로필 간 전환 정보

컨텍스트를 사용하면 CLI 작업을 사용할 때 여러 OpenShift Container Platform 서버 또는 클러스터에서 여러 사용자 간에 쉽게 전환할 수 있습니다. nickname은 컨텍스트, 사용자 인증 정보 및 클러스터 세부 정보에 대한 간단한 참조를 제공하여 CLI 구성을 보다 쉽게 관리할 수 있습니다. CLI로 처음으로 로그인한 후 OpenShift Container Platform은 아직 존재하지 않는 경우 ~/.kube/config 파일을 생성합니다. oc login 작업 중에 자동으로 또는 CLI 프로필을 수동으로 구성하여 CLI에 인증 및 연결 세부 정보가 제공되면 구성 파일에 업데이트된 정보가 저장됩니다.

CLI 구성 파일

apiVersion: v1 clusters: 1 - cluster: insecure-skip-tls-verify: true server: https://openshift1.example.com:8443 name: openshift1.example.com:8443 - cluster: insecure-skip-tls-verify: true server: https://openshift2.example.com:8443 name: openshift2.example.com:8443 contexts: 2 - context: cluster: openshift1.example.com:8443 namespace: alice-project user: alice/openshift1.example.com:8443 name: alice-project/openshift1.example.com:8443/alice - context: cluster: openshift1.example.com:8443 namespace: joe-project user: alice/openshift1.example.com:8443 name: joe-project/openshift1/alice current-context: joe-project/openshift1.example.com:8443/alice 3 kind: Config preferences: {} users: 4 - name: alice/openshift1.example.com:8443 user: token: xZHd2piv5_9vQrg-SKXRJ2Dsl9SceNJdhNTljEKTb8k

- 1

- cluster

섹션은마스터 서버의 주소를 포함하여 OpenShift Container Platform 클러스터에 대한 연결 세부 정보를 정의합니다. 이 예에서는 하나의 클러스터 이름이openshift1.example.com:8443이고 다른 클러스터는 이름이openshift2.example.com:8443입니다. - 2

- 이

context섹션은alice-project프로젝트,openshift1.example.com:8443클러스터,alice사용자, 다른 nick 이름의joe-project/openshift1.example.com:8443/alice, 즉 하나의 컨텍스트 이름을alice-project/openshift1.example.com:8443/alice, 즉 하나의 컨텍스트를 정의합니다.joe-project프로젝트,openshift1.example.com:8443클러스터 및alice사용자 사용. - 3

current-context매개변수는joe-project/openshift1.example.com:8443/alice컨텍스트가 현재 사용 중이며,alice사용자가openshift1.example.com:8443클러스터의joe-project프로젝트에서 작업할 수 있음을 보여줍니다.- 4

users섹션은 사용자 자격 증명을 정의합니다. 이 예에서 사용자 nicknamealice/openshift1.example.com:8443은 액세스 토큰을 사용합니다.

CLI는 런타임 시 로드되고 명령줄에서 지정된 덮어쓰기 옵션과 함께 병합되는 여러 구성 파일을 지원할 수 있습니다. 로그인한 후 oc status 또는 oc project 명령을 사용하여 현재 작업 환경을 확인할 수 있습니다.

현재 작업 중인 환경 확인

$ oc status

출력 예

oc status

In project Joe's Project (joe-project)

service database (172.30.43.12:5434 -> 3306)

database deploys docker.io/openshift/mysql-55-centos7:latest

#1 deployed 25 minutes ago - 1 pod

service frontend (172.30.159.137:5432 -> 8080)

frontend deploys origin-ruby-sample:latest <-

builds https://github.com/openshift/ruby-hello-world with joe-project/ruby-20-centos7:latest

#1 deployed 22 minutes ago - 2 pods

To see more information about a service or deployment, use 'oc describe service <name>' or 'oc describe dc <name>'.

You can use 'oc get all' to see lists of each of the types described in this example.

현재 프로젝트 나열

$ oc project

출력 예

Using project "joe-project" from context named "joe-project/openshift1.example.com:8443/alice" on server "https://openshift1.example.com:8443".

oc login 명령을 다시 실행하고 대화형 프로세스 중에 필요한 정보를 제공하여 사용자 인증 정보 및 클러스터 세부 정보의 다른 조합을 사용하여 로그인할 수 있습니다. 컨텍스트는 아직 존재하지 않는 경우 제공된 정보를 기반으로 구성됩니다. 이미 로그인한 후 현재 사용자가 이미 액세스할 수 있는 다른 프로젝트로 전환하려면 oc project 명령을 사용하여 프로젝트 이름을 입력합니다.

$ oc project alice-project

출력 예

Now using project "alice-project" on server "https://openshift1.example.com:8443".

출력에 표시된 대로 oc config view 명령을 사용하여 현재 CLI 구성을 볼 수 있습니다. 고급 사용을 위해 추가 CLI 구성 명령을 사용할 수도 있습니다.

관리자 자격 증명에 액세스할 수 있지만 더 이상 기본 시스템 사용자 system:admin 으로 로그인하지 않은 경우 CLI 구성 파일에 인증 정보가 계속 있는 한 언제든지 이 사용자로 다시 로그인할 수 있습니다. 다음 명령은 기본 프로젝트에 로그인하여 전환합니다.

$ oc login -u system:admin -n default

2.3.2. CLI 프로필 수동 구성

이 섹션에서는 CLI 구성의 고급 사용에 대해 설명합니다. 대부분의 경우 oc login 및 oc project 명령을 사용하여 컨텍스트와 프로젝트를 로그인하고 전환할 수 있습니다.

CLI 구성 파일을 수동으로 구성하려면 파일을 직접 수정하는 대신 oc config 명령을 사용할 수 있습니다. oc config 명령에는 다음과 같은 목적으로 유용한 여러 하위 명령이 포함되어 있습니다.

표 2.1. CLI 구성 하위 명령

| 하위 명령 | 사용법 |

|---|---|

|

| CLI 구성 파일에 클러스터 항목을 설정합니다. 참조된 클러스터 닉네임이 이미 존재하는 경우 지정된 정보가 에 병합됩니다. $ oc config set-cluster <cluster_nickname> [--server=<master_ip_or_fqdn>] [--certificate-authority=<path/to/certificate/authority>] [--api-version=<apiversion>] [--insecure-skip-tls-verify=true] |

|

| CLI 구성 파일에 컨텍스트 항목을 설정합니다. 참조된 컨텍스트 닉네임이 이미 있는 경우 지정된 정보가 에 병합됩니다. $ oc config set-context <context_nickname> [--cluster=<cluster_nickname>] [--user=<user_nickname>] [--namespace=<namespace>] |

|

| 지정된 컨텍스트 nickname을 사용하여 현재 컨텍스트를 설정합니다. $ oc config use-context <context_nickname> |

|

| CLI 구성 파일에서 개별 값을 설정합니다. $ oc config set <property_name> <property_value>

|

|

| CLI 구성 파일에서 개별 값을 설정 해제합니다. $ oc config unset <property_name>

|

|

| 현재 사용 중인 병합된 CLI 구성을 표시합니다. $ oc config view 지정된 CLI 구성 파일의 결과를 표시합니다. $ oc config view --config=<specific_filename> |

사용 예

-

액세스 토큰을 사용하는 사용자로 로그인합니다. 이 토큰은

alice사용자가 사용합니다.

$ oc login https://openshift1.example.com --token=ns7yVhuRNpDM9cgzfhhxQ7bM5s7N2ZVrkZepSRf4LC0

- 자동으로 생성된 클러스터 항목을 확인합니다.

$ oc config view

출력 예

apiVersion: v1

clusters:

- cluster:

insecure-skip-tls-verify: true

server: https://openshift1.example.com

name: openshift1-example-com

contexts:

- context:

cluster: openshift1-example-com

namespace: default

user: alice/openshift1-example-com

name: default/openshift1-example-com/alice

current-context: default/openshift1-example-com/alice

kind: Config

preferences: {}

users:

- name: alice/openshift1.example.com

user:

token: ns7yVhuRNpDM9cgzfhhxQ7bM5s7N2ZVrkZepSRf4LC0

- 사용자가 원하는 네임스페이스에 로그인하도록 현재 컨텍스트를 업데이트합니다.

$ oc config set-context `oc config current-context` --namespace=<project_name>

- 현재 컨텍스트를 검사하여 변경 사항이 구현되었는지 확인합니다.

$ oc whoami -c

CLI 옵션을 재정의하거나 컨텍스트가 전환될 때까지 달리 지정하지 않는 한 모든 후속 CLI 작업은 새 컨텍스트를 사용합니다.

2.3.3. 규칙 로드 및 병합

CLI 구성에 대한 CLI 작업을 실행할 때 다음 규칙을 따를 수 있습니다.

CLI 구성 파일은 다음 계층 및 병합 규칙을 사용하여 워크스테이션에서 검색됩니다.

-

--config옵션이 설정되면 해당 파일만 로드됩니다. 플래그는 한 번 설정되고 병합이 수행되지 않습니다. -

$KUBECONFIG환경 변수가 설정되면 사용됩니다. 변수가 경로 목록일 수 있으며, 경로가 함께 병합되는 경우도 있습니다. 값을 수정하면 스탠자를 정의하는 파일에서 수정됩니다. 값이 생성되면 존재하는 첫 번째 파일에 생성됩니다. 체인에 파일이 없으면 목록에 마지막 파일을 만듭니다. -

그렇지 않으면

~/.kube/config파일이 사용되며 병합이 수행되지 않습니다.

-

사용할 컨텍스트는 다음 흐름의 첫 번째 일치에 따라 결정됩니다.

-

--context옵션의 값입니다. -

CLI 구성 파일의

current-context값입니다. - 이 단계에서는 빈 값이 허용됩니다.

-

사용할 사용자 및 클러스터가 결정됩니다. 이 시점에는 컨텍스트가 있거나 없을 수 있습니다. 다음 흐름에서 첫 번째 일치를 기반으로 빌드되며, 이는 사용자와 클러스터에 대해 한 번 실행됩니다.

-

클러스터 이름에 대한

--user및 사용자 이름에 대한--cluster옵션의 값입니다. -

context

옵션이 있는경우 컨텍스트의 값을 사용합니다. - 이 단계에서는 빈 값이 허용됩니다.

-

클러스터 이름에 대한

사용할 실제 클러스터 정보가 결정됩니다. 이 시점에서 클러스터 정보가 있거나 없을 수 있습니다. 클러스터 정보의 각 조각은 다음 흐름에서 첫 번째 일치를 기반으로 빌드됩니다.

다음 명령줄 옵션의 값:

-

--server, -

--api-version -

--certificate-authority -

--insecure-skip-tls-verify

-

- 클러스터 정보와 속성 값이 있는 경우 이를 사용합니다.

- 서버 위치가 없는 경우 오류가 발생합니다.

사용할 실제 사용자 정보가 결정됩니다. 사용자는 사용자당 하나의 인증 기술만 가질 수 있다는 점을 제외하고 클러스터와 동일한 규칙을 사용하여 빌드됩니다. 충돌하는 기술은 작업이 실패합니다. 명령줄 옵션이 구성 파일 값보다 우선합니다. 유효한 명령줄 옵션은 다음과 같습니다.

-

--auth-path -

--client-certificate -

--client-key -

--token

-

- 여전히 누락된 모든 정보에 대해 기본값이 사용되며 추가 정보를 입력하라는 메시지가 표시됩니다.

2.4. 플러그인을 사용하여 OpenShift CLI 확장

기본 oc 명령에 빌드할 플러그인을 작성하고 설치하여 OpenShift Container Platform CLI에서 새롭고 더 복잡한 작업을 수행할 수 있습니다.

2.4.1. CLI 플러그인 작성

명령줄 명령을 작성할 수 있는 모든 프로그래밍 언어 또는 스크립트로 OpenShift Container Platform CLI용 플러그인을 작성할 수 있습니다. 플러그인을 사용하여 기존 oc 명령을 덮어쓸 수 없습니다.

절차

이 절차에서는 oc foo 명령을 실행할 때 메시지를 터미널에 출력하는 간단한 Bash 플러그인을 생성합니다.

oc-foo라는 파일을 생성합니다.플러그인 파일의 이름을 지정할 때 다음 사항에 유의하십시오.

-

파일이 플러그인으로 인식되려면

oc-또는kubectl-로 시작되어야 합니다. -

파일 이름에 따라 플러그인을 호출하는 명령이 결정됩니다. 예를 들어 파일 이름이

oc-foo-bar인 플러그인은oc foo bar명령으로 호출할 수 있습니다. 명령에 대시를 포함하기 위해 밑줄을 사용할 수도 있습니다. 예를 들어 파일 이름이oc-foo_bar인 플러그인은oc foo-bar명령으로 호출할 수 있습니다.

-

파일이 플러그인으로 인식되려면

파일에 다음 콘텐츠를 추가합니다.

#!/bin/bash # optional argument handling if [[ "$1" == "version" ]] then echo "1.0.0" exit 0 fi # optional argument handling if [[ "$1" == "config" ]] then echo $KUBECONFIG exit 0 fi echo "I am a plugin named kubectl-foo"

OpenShift Container Platform CLI용으로 이 플러그인을 설치한 후에는 oc foo 명령을 사용하여 호출할 수 있습니다.

추가 리소스

- Go에서 작성된 플러그인의 예를 보려면 Sample 플러그인 리포지토리 를 검토합니다.

- Go에서 플러그인을 작성하는 데 도움이 되는 유틸리티 세트는 CLI 런타임 리포지터리 를 검토하십시오.

2.4.2. CLI 플러그인 설치 및 사용

OpenShift Container Platform CLI용 사용자 정의 플러그인을 작성한 후에는 해당 플러그인을 설치하여 제공하는 기능을 사용해야 합니다.

사전 요구 사항

-

ocCLI 툴이 설치되어 있어야 합니다. -

oc-또는kubectl-로 시작하는 CLI 플러그인 파일이 있어야 합니다.

절차

필요한 경우 플러그인 파일을 실행 가능하게 업데이트합니다.

$ chmod +x <plugin_file>

파일을

PATH에 있는 임의의 위치(예:/usr/local/bin/)에 배치합니다.$ sudo mv <plugin_file> /usr/local/bin/.

oc plugin list를 실행하여 플러그인이 나열되었는지 확인합니다.$ oc plugin list

출력 예

The following compatible plugins are available: /usr/local/bin/<plugin_file>

여기에 플러그인이 나열되지 않은 경우 파일이

oc-또는kubectl-로 시작하고 실행 가능하며PATH에 있는지 확인합니다.플러그인에서 도입한 새 명령 또는 옵션을 호출합니다.

예를 들어 샘플 플러그인 리포지토리 에서

kubectl-ns플러그인을 빌드하고 설치한 경우 다음 명령을 사용하여 현재 네임스페이스를 볼 수 있습니다.$ oc ns

플러그인을 호출하는 명령은 플러그인 파일 이름에 따라 다릅니다. 예를 들어 파일 이름이

oc-foo-bar인 플러그인은oc foo bar명령으로 호출합니다.

2.5. OpenShift CLI 개발자 명령 참조

이 참조는 OpenShift CLI (oc) developer 명령에 대한 설명 및 예제 명령을 제공합니다. 관리자 명령의 경우 OpenShift CLI 관리자 명령 참조에서 참조하십시오.

oc help를 실행하여 모든 명령을 나열하거나 oc <command> --help를 실행하여 특정 명령에 대한 추가 세부 정보를 가져옵니다.

2.5.1. OpenShift CLI (oc) 개발자 명령

2.5.1.1. oc annotate

리소스에서 주석을 업데이트

사용 예

# Update pod 'foo' with the annotation 'description' and the value 'my frontend'. # If the same annotation is set multiple times, only the last value will be applied oc annotate pods foo description='my frontend' # Update a pod identified by type and name in "pod.json" oc annotate -f pod.json description='my frontend' # Update pod 'foo' with the annotation 'description' and the value 'my frontend running nginx', overwriting any existing value. oc annotate --overwrite pods foo description='my frontend running nginx' # Update all pods in the namespace oc annotate pods --all description='my frontend running nginx' # Update pod 'foo' only if the resource is unchanged from version 1. oc annotate pods foo description='my frontend running nginx' --resource-version=1 # Update pod 'foo' by removing an annotation named 'description' if it exists. # Does not require the --overwrite flag. oc annotate pods foo description-

2.5.1.2. oc api-resources

서버에서 지원되는 API 리소스를 인쇄

사용 예

# Print the supported API Resources oc api-resources # Print the supported API Resources with more information oc api-resources -o wide # Print the supported API Resources sorted by a column oc api-resources --sort-by=name # Print the supported namespaced resources oc api-resources --namespaced=true # Print the supported non-namespaced resources oc api-resources --namespaced=false # Print the supported API Resources with specific APIGroup oc api-resources --api-group=extensions

2.5.1.3. oc api-versions

"group/version" 형식으로 서버에서 지원되는 API 버전을 인쇄

사용 예

# Print the supported API versions oc api-versions

2.5.1.4. oc apply

파일 이름 또는 stdin을 사용하여 리소스에 설정을 적용

사용 예

# Apply the configuration in pod.json to a pod. oc apply -f ./pod.json # Apply resources from a directory containing kustomization.yaml - e.g. dir/kustomization.yaml. oc apply -k dir/ # Apply the JSON passed into stdin to a pod. cat pod.json | oc apply -f - # Note: --prune is still in Alpha # Apply the configuration in manifest.yaml that matches label app=nginx and delete all the other resources that are not in the file and match label app=nginx. oc apply --prune -f manifest.yaml -l app=nginx # Apply the configuration in manifest.yaml and delete all the other configmaps that are not in the file. oc apply --prune -f manifest.yaml --all --prune-whitelist=core/v1/ConfigMap

2.5.1.5. oc apply edit-last-applied

리소스/오브젝트의 최신 last-applied-configuration 주석을 편집

사용 예

# Edit the last-applied-configuration annotations by type/name in YAML. oc apply edit-last-applied deployment/nginx # Edit the last-applied-configuration annotations by file in JSON. oc apply edit-last-applied -f deploy.yaml -o json

2.5.1.6. oc apply set-last-applied

파일의 내용과 일치하도록 라이브 오브젝트에 last-applied-configuration 주석을 설정

사용 예

# Set the last-applied-configuration of a resource to match the contents of a file. oc apply set-last-applied -f deploy.yaml # Execute set-last-applied against each configuration file in a directory. oc apply set-last-applied -f path/ # Set the last-applied-configuration of a resource to match the contents of a file, will create the annotation if it does not already exist. oc apply set-last-applied -f deploy.yaml --create-annotation=true

2.5.1.7. oc apply view-last-applied

리소스/오브젝트의 최신 last-applied-configuration 주석을 확인

사용 예

# View the last-applied-configuration annotations by type/name in YAML. oc apply view-last-applied deployment/nginx # View the last-applied-configuration annotations by file in JSON oc apply view-last-applied -f deploy.yaml -o json

2.5.1.8. oc attach

실행 중인 컨테이너에 연결

사용 예

# Get output from running pod mypod, use the oc.kubernetes.io/default-container annotation # for selecting the container to be attached or the first container in the pod will be chosen oc attach mypod # Get output from ruby-container from pod mypod oc attach mypod -c ruby-container # Switch to raw terminal mode, sends stdin to 'bash' in ruby-container from pod mypod # and sends stdout/stderr from 'bash' back to the client oc attach mypod -c ruby-container -i -t # Get output from the first pod of a ReplicaSet named nginx oc attach rs/nginx

2.5.1.9. oc auth can-i

작업이 허용되는지 확인

사용 예

# Check to see if I can create pods in any namespace

oc auth can-i create pods --all-namespaces

# Check to see if I can list deployments in my current namespace

oc auth can-i list deployments.apps

# Check to see if I can do everything in my current namespace ("*" means all)

oc auth can-i '*' '*'

# Check to see if I can get the job named "bar" in namespace "foo"

oc auth can-i list jobs.batch/bar -n foo

# Check to see if I can read pod logs

oc auth can-i get pods --subresource=log

# Check to see if I can access the URL /logs/

oc auth can-i get /logs/

# List all allowed actions in namespace "foo"

oc auth can-i --list --namespace=foo

2.5.1.10. oc auth reconcile

RBAC Role, RoleBinding, ClusterRole 및 ClusterRoleBinding 오브젝트에 대한 규칙을 조정

사용 예

# Reconcile rbac resources from a file oc auth reconcile -f my-rbac-rules.yaml

2.5.1.11. oc autoscale

배포 구성, 배포, 복제본 세트, 상태 저장 세트 또는 복제 컨트롤러를 자동 스케일링

사용 예

# Auto scale a deployment "foo", with the number of pods between 2 and 10, no target CPU utilization specified so a default autoscaling policy will be used: oc autoscale deployment foo --min=2 --max=10 # Auto scale a replication controller "foo", with the number of pods between 1 and 5, target CPU utilization at 80%: oc autoscale rc foo --max=5 --cpu-percent=80

2.5.1.12. oc cancel-build

실행 중이거나 보류 중인 빌드 또는 새 빌드를 취소

사용 예

# Cancel the build with the given name oc cancel-build ruby-build-2 # Cancel the named build and print the build logs oc cancel-build ruby-build-2 --dump-logs # Cancel the named build and create a new one with the same parameters oc cancel-build ruby-build-2 --restart # Cancel multiple builds oc cancel-build ruby-build-1 ruby-build-2 ruby-build-3 # Cancel all builds created from the 'ruby-build' build config that are in the 'new' state oc cancel-build bc/ruby-build --state=new

2.5.1.13. oc cluster-info

클러스터 정보를 표시

사용 예

# Print the address of the control plane and cluster services oc cluster-info

2.5.1.14. oc cluster-info dump

디버깅 및 진단을 위해 많은 관련 정보를 덤프

사용 예

# Dump current cluster state to stdout oc cluster-info dump # Dump current cluster state to /path/to/cluster-state oc cluster-info dump --output-directory=/path/to/cluster-state # Dump all namespaces to stdout oc cluster-info dump --all-namespaces # Dump a set of namespaces to /path/to/cluster-state oc cluster-info dump --namespaces default,kube-system --output-directory=/path/to/cluster-state

2.5.1.15. oc completion

지정된 쉘에 대한 쉘 완료 코드를 출력 (bash 또는 zsh)

사용 예

# Installing bash completion on macOS using homebrew

## If running Bash 3.2 included with macOS

brew install bash-completion

## or, if running Bash 4.1+

brew install bash-completion@2

## If oc is installed via homebrew, this should start working immediately.

## If you've installed via other means, you may need add the completion to your completion directory

oc completion bash > $(brew --prefix)/etc/bash_completion.d/oc

# Installing bash completion on Linux

## If bash-completion is not installed on Linux, please install the 'bash-completion' package

## via your distribution's package manager.

## Load the oc completion code for bash into the current shell

source <(oc completion bash)

## Write bash completion code to a file and source it from .bash_profile

oc completion bash > ~/.kube/completion.bash.inc

printf "

# Kubectl shell completion

source '$HOME/.kube/completion.bash.inc'

" >> $HOME/.bash_profile

source $HOME/.bash_profile

# Load the oc completion code for zsh[1] into the current shell

source <(oc completion zsh)

# Set the oc completion code for zsh[1] to autoload on startup

oc completion zsh > "${fpath[1]}/_oc"

2.5.1.16. oc config current-context

current-context를 표시

사용 예

# Display the current-context oc config current-context

2.5.1.17. oc config delete-cluster

kubeconfig에서 지정된 클러스터를 삭제

사용 예

# Delete the minikube cluster oc config delete-cluster minikube

2.5.1.18. oc config delete-context

kubeconfig에서 지정된 컨텍스트를 삭제

사용 예

# Delete the context for the minikube cluster oc config delete-context minikube

2.5.1.19. oc config delete-user

kubeconfig에서 지정된 사용자를 삭제

사용 예

# Delete the minikube user oc config delete-user minikube

2.5.1.20. oc config get-clusters

kubeconfig에 정의된 클러스터를 표시

사용 예

# List the clusters oc knows about oc config get-clusters

2.5.1.21. oc config get-contexts

하나 또는 여러 컨텍스트를 설명

사용 예

# List all the contexts in your kubeconfig file oc config get-contexts # Describe one context in your kubeconfig file. oc config get-contexts my-context

2.5.1.22. oc config get-users

kubeconfig에 정의된 사용자를 표시

사용 예

# List the users oc knows about oc config get-users

2.5.1.23. oc config rename-context

kubeconfig 파일에서 컨텍스트의 이름을 변경

사용 예

# Rename the context 'old-name' to 'new-name' in your kubeconfig file oc config rename-context old-name new-name

2.5.1.24. oc config set

kubeconfig 파일에서 개별 값을 설정

사용 예

# Set server field on the my-cluster cluster to https://1.2.3.4 oc config set clusters.my-cluster.server https://1.2.3.4 # Set certificate-authority-data field on the my-cluster cluster. oc config set clusters.my-cluster.certificate-authority-data $(echo "cert_data_here" | base64 -i -) # Set cluster field in the my-context context to my-cluster. oc config set contexts.my-context.cluster my-cluster # Set client-key-data field in the cluster-admin user using --set-raw-bytes option. oc config set users.cluster-admin.client-key-data cert_data_here --set-raw-bytes=true

2.5.1.25. oc config set-cluster

kubeconfig에서 클러스터 항목을 설정

사용 예

# Set only the server field on the e2e cluster entry without touching other values. oc config set-cluster e2e --server=https://1.2.3.4 # Embed certificate authority data for the e2e cluster entry oc config set-cluster e2e --embed-certs --certificate-authority=~/.kube/e2e/kubernetes.ca.crt # Disable cert checking for the dev cluster entry oc config set-cluster e2e --insecure-skip-tls-verify=true # Set custom TLS server name to use for validation for the e2e cluster entry oc config set-cluster e2e --tls-server-name=my-cluster-name

2.5.1.26. oc config set-context

kubeconfig에서 컨텍스트 항목을 설정

사용 예

# Set the user field on the gce context entry without touching other values oc config set-context gce --user=cluster-admin

2.5.1.27. oc config set-credentials

kubeconfig에서 사용자 항목을 설정

사용 예

# Set only the "client-key" field on the "cluster-admin" # entry, without touching other values: oc config set-credentials cluster-admin --client-key=~/.kube/admin.key # Set basic auth for the "cluster-admin" entry oc config set-credentials cluster-admin --username=admin --password=uXFGweU9l35qcif # Embed client certificate data in the "cluster-admin" entry oc config set-credentials cluster-admin --client-certificate=~/.kube/admin.crt --embed-certs=true # Enable the Google Compute Platform auth provider for the "cluster-admin" entry oc config set-credentials cluster-admin --auth-provider=gcp # Enable the OpenID Connect auth provider for the "cluster-admin" entry with additional args oc config set-credentials cluster-admin --auth-provider=oidc --auth-provider-arg=client-id=foo --auth-provider-arg=client-secret=bar # Remove the "client-secret" config value for the OpenID Connect auth provider for the "cluster-admin" entry oc config set-credentials cluster-admin --auth-provider=oidc --auth-provider-arg=client-secret- # Enable new exec auth plugin for the "cluster-admin" entry oc config set-credentials cluster-admin --exec-command=/path/to/the/executable --exec-api-version=client.authentication.k8s.io/v1beta1 # Define new exec auth plugin args for the "cluster-admin" entry oc config set-credentials cluster-admin --exec-arg=arg1 --exec-arg=arg2 # Create or update exec auth plugin environment variables for the "cluster-admin" entry oc config set-credentials cluster-admin --exec-env=key1=val1 --exec-env=key2=val2 # Remove exec auth plugin environment variables for the "cluster-admin" entry oc config set-credentials cluster-admin --exec-env=var-to-remove-

2.5.1.28. oc config unset

kubeconfig 파일에서 개별 값 설정을 해제

사용 예

# Unset the current-context. oc config unset current-context # Unset namespace in foo context. oc config unset contexts.foo.namespace

2.5.1.29. oc config use-context

kubeconfig 파일에서 current-context를 설정

사용 예

# Use the context for the minikube cluster oc config use-context minikube

2.5.1.30. oc config view

병합된 kubeconfig 설정 또는 지정된 kubeconfig 파일을 표시

사용 예

# Show merged kubeconfig settings.

oc config view

# Show merged kubeconfig settings and raw certificate data.

oc config view --raw

# Get the password for the e2e user

oc config view -o jsonpath='{.users[?(@.name == "e2e")].user.password}'

2.5.1.31. oc cp

컨테이너 간에 파일 및 디렉터리를 복사

사용 예

# !!!Important Note!!! # Requires that the 'tar' binary is present in your container # image. If 'tar' is not present, 'oc cp' will fail. # # For advanced use cases, such as symlinks, wildcard expansion or # file mode preservation consider using 'oc exec'. # Copy /tmp/foo local file to /tmp/bar in a remote pod in namespace <some-namespace> tar cf - /tmp/foo | oc exec -i -n <some-namespace> <some-pod> -- tar xf - -C /tmp/bar # Copy /tmp/foo from a remote pod to /tmp/bar locally oc exec -n <some-namespace> <some-pod> -- tar cf - /tmp/foo | tar xf - -C /tmp/bar # Copy /tmp/foo_dir local directory to /tmp/bar_dir in a remote pod in the default namespace oc cp /tmp/foo_dir <some-pod>:/tmp/bar_dir # Copy /tmp/foo local file to /tmp/bar in a remote pod in a specific container oc cp /tmp/foo <some-pod>:/tmp/bar -c <specific-container> # Copy /tmp/foo local file to /tmp/bar in a remote pod in namespace <some-namespace> oc cp /tmp/foo <some-namespace>/<some-pod>:/tmp/bar # Copy /tmp/foo from a remote pod to /tmp/bar locally oc cp <some-namespace>/<some-pod>:/tmp/foo /tmp/bar

2.5.1.32. oc create

파일 또는 stdin에서 리소스를 생성

사용 예

# Create a pod using the data in pod.json. oc create -f ./pod.json # Create a pod based on the JSON passed into stdin. cat pod.json | oc create -f - # Edit the data in docker-registry.yaml in JSON then create the resource using the edited data. oc create -f docker-registry.yaml --edit -o json

2.5.1.33. oc create build

새 빌드를 생성

사용 예

# Create a new build oc create build myapp

2.5.1.34. oc create clusterresourcequota

클러스터 리소스 쿼터를 생성

사용 예

# Create a cluster resource quota limited to 10 pods oc create clusterresourcequota limit-bob --project-annotation-selector=openshift.io/requester=user-bob --hard=pods=10

2.5.1.35. oc create clusterrole

클러스터 역할을 생성

사용 예

# Create a ClusterRole named "pod-reader" that allows user to perform "get", "watch" and "list" on pods oc create clusterrole pod-reader --verb=get,list,watch --resource=pods # Create a ClusterRole named "pod-reader" with ResourceName specified oc create clusterrole pod-reader --verb=get --resource=pods --resource-name=readablepod --resource-name=anotherpod # Create a ClusterRole named "foo" with API Group specified oc create clusterrole foo --verb=get,list,watch --resource=rs.extensions # Create a ClusterRole named "foo" with SubResource specified oc create clusterrole foo --verb=get,list,watch --resource=pods,pods/status # Create a ClusterRole name "foo" with NonResourceURL specified oc create clusterrole "foo" --verb=get --non-resource-url=/logs/* # Create a ClusterRole name "monitoring" with AggregationRule specified oc create clusterrole monitoring --aggregation-rule="rbac.example.com/aggregate-to-monitoring=true"

2.5.1.36. oc create clusterrolebinding

특정 ClusterRole에 대한 ClusterRoleBinding을 생성

사용 예

# Create a ClusterRoleBinding for user1, user2, and group1 using the cluster-admin ClusterRole oc create clusterrolebinding cluster-admin --clusterrole=cluster-admin --user=user1 --user=user2 --group=group1

2.5.1.37. oc create configmap

로컬 파일, 디렉토리 또는 리터럴 값에서 구성 맵을 생성

사용 예

# Create a new configmap named my-config based on folder bar oc create configmap my-config --from-file=path/to/bar # Create a new configmap named my-config with specified keys instead of file basenames on disk oc create configmap my-config --from-file=key1=/path/to/bar/file1.txt --from-file=key2=/path/to/bar/file2.txt # Create a new configmap named my-config with key1=config1 and key2=config2 oc create configmap my-config --from-literal=key1=config1 --from-literal=key2=config2 # Create a new configmap named my-config from the key=value pairs in the file oc create configmap my-config --from-file=path/to/bar # Create a new configmap named my-config from an env file oc create configmap my-config --from-env-file=path/to/bar.env

2.5.1.38. oc create cronjob

지정된 이름으로 cronjob을 생성

사용 예

# Create a cronjob oc create cronjob my-job --image=busybox --schedule="*/1 * * * *" # Create a cronjob with command oc create cronjob my-job --image=busybox --schedule="*/1 * * * *" -- date

2.5.1.39. oc create deployment

지정된 이름으로 배포를 생성

사용 예

# Create a deployment named my-dep that runs the busybox image. oc create deployment my-dep --image=busybox # Create a deployment with command oc create deployment my-dep --image=busybox -- date # Create a deployment named my-dep that runs the nginx image with 3 replicas. oc create deployment my-dep --image=nginx --replicas=3 # Create a deployment named my-dep that runs the busybox image and expose port 5701. oc create deployment my-dep --image=busybox --port=5701

2.5.1.40. oc create deploymentconfig

지정된 이미지를 사용하는 기본 옵션으로 배포 구성을 생성

사용 예

# Create an nginx deployment config named my-nginx oc create deploymentconfig my-nginx --image=nginx

2.5.1.41. oc create identity

수동으로 ID를 생성 (자동 생성이 비활성화된 경우에만 필요)

사용 예

# Create an identity with identity provider "acme_ldap" and the identity provider username "adamjones" oc create identity acme_ldap:adamjones

2.5.1.42. oc create imagestream

비어 있는 새 이미지 스트림을 생성

사용 예

# Create a new image stream oc create imagestream mysql

2.5.1.43. oc create imagestreamtag

새 이미지 스트림 태그를 생성

사용 예

# Create a new image stream tag based on an image in a remote registry oc create imagestreamtag mysql:latest --from-image=myregistry.local/mysql/mysql:5.0

2.5.1.44. oc create ingress

지정된 이름으로 수신을 생성

사용 예

# Create a single ingress called 'simple' that directs requests to foo.com/bar to svc # svc1:8080 with a tls secret "my-cert" oc create ingress simple --rule="foo.com/bar=svc1:8080,tls=my-cert" # Create a catch all ingress of "/path" pointing to service svc:port and Ingress Class as "otheringress" oc create ingress catch-all --class=otheringress --rule="/path=svc:port" # Create an ingress with two annotations: ingress.annotation1 and ingress.annotations2 oc create ingress annotated --class=default --rule="foo.com/bar=svc:port" \ --annotation ingress.annotation1=foo \ --annotation ingress.annotation2=bla # Create an ingress with the same host and multiple paths oc create ingress multipath --class=default \ --rule="foo.com/=svc:port" \ --rule="foo.com/admin/=svcadmin:portadmin" # Create an ingress with multiple hosts and the pathType as Prefix oc create ingress ingress1 --class=default \ --rule="foo.com/path*=svc:8080" \ --rule="bar.com/admin*=svc2:http" # Create an ingress with TLS enabled using the default ingress certificate and different path types oc create ingress ingtls --class=default \ --rule="foo.com/=svc:https,tls" \ --rule="foo.com/path/subpath*=othersvc:8080" # Create an ingress with TLS enabled using a specific secret and pathType as Prefix oc create ingress ingsecret --class=default \ --rule="foo.com/*=svc:8080,tls=secret1" # Create an ingress with a default backend oc create ingress ingdefault --class=default \ --default-backend=defaultsvc:http \ --rule="foo.com/*=svc:8080,tls=secret1"

2.5.1.45. oc create job

지정된 이름으로 작업을 생성

사용 예

# Create a job oc create job my-job --image=busybox # Create a job with command oc create job my-job --image=busybox -- date # Create a job from a CronJob named "a-cronjob" oc create job test-job --from=cronjob/a-cronjob

2.5.1.46. oc create namespace

지정된 이름으로 네임 스페이스를 생성

사용 예

# Create a new namespace named my-namespace oc create namespace my-namespace

2.5.1.47. oc create poddisruptionbudget

지정된 이름으로 Pod 중단 예산을 생성

사용 예

# Create a pod disruption budget named my-pdb that will select all pods with the app=rails label # and require at least one of them being available at any point in time. oc create poddisruptionbudget my-pdb --selector=app=rails --min-available=1 # Create a pod disruption budget named my-pdb that will select all pods with the app=nginx label # and require at least half of the pods selected to be available at any point in time. oc create pdb my-pdb --selector=app=nginx --min-available=50%

2.5.1.48. oc create priorityclass

지정된 이름으로 priorityclass를 생성

사용 예

# Create a priorityclass named high-priority oc create priorityclass high-priority --value=1000 --description="high priority" # Create a priorityclass named default-priority that considered as the global default priority oc create priorityclass default-priority --value=1000 --global-default=true --description="default priority" # Create a priorityclass named high-priority that can not preempt pods with lower priority oc create priorityclass high-priority --value=1000 --description="high priority" --preemption-policy="Never"

2.5.1.49. oc create quota

지정된 이름의 쿼터를 생성

사용 예

# Create a new resourcequota named my-quota oc create quota my-quota --hard=cpu=1,memory=1G,pods=2,services=3,replicationcontrollers=2,resourcequotas=1,secrets=5,persistentvolumeclaims=10 # Create a new resourcequota named best-effort oc create quota best-effort --hard=pods=100 --scopes=BestEffort

2.5.1.50. oc create role

단일 규칙을 사용하여 역할을 생성

사용 예

# Create a Role named "pod-reader" that allows user to perform "get", "watch" and "list" on pods oc create role pod-reader --verb=get --verb=list --verb=watch --resource=pods # Create a Role named "pod-reader" with ResourceName specified oc create role pod-reader --verb=get --resource=pods --resource-name=readablepod --resource-name=anotherpod # Create a Role named "foo" with API Group specified oc create role foo --verb=get,list,watch --resource=rs.extensions # Create a Role named "foo" with SubResource specified oc create role foo --verb=get,list,watch --resource=pods,pods/status

2.5.1.51. oc create rolebinding

특정 역할 또는 ClusterRole에 대한 RoleBinding을 생성

사용 예

# Create a RoleBinding for user1, user2, and group1 using the admin ClusterRole oc create rolebinding admin --clusterrole=admin --user=user1 --user=user2 --group=group1

2.5.1.52. oc create route edge

엣지 TLS 종료를 사용하는 경로를 생성

사용 예

# Create an edge route named "my-route" that exposes the frontend service oc create route edge my-route --service=frontend # Create an edge route that exposes the frontend service and specify a path # If the route name is omitted, the service name will be used oc create route edge --service=frontend --path /assets

2.5.1.53. oc create route passthrough

패스스루 TLS 종료를 사용하는 경로를 생성

사용 예

# Create a passthrough route named "my-route" that exposes the frontend service oc create route passthrough my-route --service=frontend # Create a passthrough route that exposes the frontend service and specify # a host name. If the route name is omitted, the service name will be used oc create route passthrough --service=frontend --hostname=www.example.com

2.5.1.54. oc create route reencrypt

재암호화 TLS 종료를 사용하는 경로를 생성

사용 예

# Create a route named "my-route" that exposes the frontend service oc create route reencrypt my-route --service=frontend --dest-ca-cert cert.cert # Create a reencrypt route that exposes the frontend service, letting the # route name default to the service name and the destination CA certificate # default to the service CA oc create route reencrypt --service=frontend

2.5.1.55. oc create secret docker-registry

Docker 레지스트리와 함께 사용할 시크릿을 생성

사용 예

# If you don't already have a .dockercfg file, you can create a dockercfg secret directly by using: oc create secret docker-registry my-secret --docker-server=DOCKER_REGISTRY_SERVER --docker-username=DOCKER_USER --docker-password=DOCKER_PASSWORD --docker-email=DOCKER_EMAIL # Create a new secret named my-secret from ~/.docker/config.json oc create secret docker-registry my-secret --from-file=.dockerconfigjson=path/to/.docker/config.json

2.5.1.56. oc create secret generic

로컬 파일, 디렉터리 또는 리터럴 값에서 시크릿을 생성

사용 예

# Create a new secret named my-secret with keys for each file in folder bar oc create secret generic my-secret --from-file=path/to/bar # Create a new secret named my-secret with specified keys instead of names on disk oc create secret generic my-secret --from-file=ssh-privatekey=path/to/id_rsa --from-file=ssh-publickey=path/to/id_rsa.pub # Create a new secret named my-secret with key1=supersecret and key2=topsecret oc create secret generic my-secret --from-literal=key1=supersecret --from-literal=key2=topsecret # Create a new secret named my-secret using a combination of a file and a literal oc create secret generic my-secret --from-file=ssh-privatekey=path/to/id_rsa --from-literal=passphrase=topsecret # Create a new secret named my-secret from an env file oc create secret generic my-secret --from-env-file=path/to/bar.env

2.5.1.57. oc create secret tls

TLS 시크릿을 생성

사용 예

# Create a new TLS secret named tls-secret with the given key pair: oc create secret tls tls-secret --cert=path/to/tls.cert --key=path/to/tls.key

2.5.1.58. oc create service clusterip

ClusterIP 서비스를 생성

사용 예

# Create a new ClusterIP service named my-cs oc create service clusterip my-cs --tcp=5678:8080 # Create a new ClusterIP service named my-cs (in headless mode) oc create service clusterip my-cs --clusterip="None"

2.5.1.59. oc create service externalname

ExternalName 서비스를 생성

사용 예

# Create a new ExternalName service named my-ns oc create service externalname my-ns --external-name bar.com

2.5.1.60. oc create service loadbalancer

LoadBalancer 서비스를 생성

사용 예

# Create a new LoadBalancer service named my-lbs oc create service loadbalancer my-lbs --tcp=5678:8080

2.5.1.61. oc create service nodeport

NodePort 서비스를 생성

사용 예

# Create a new NodePort service named my-ns oc create service nodeport my-ns --tcp=5678:8080

2.5.1.62. oc create serviceaccount

지정된 이름으로 서비스 계정을 생성

사용 예

# Create a new service account named my-service-account oc create serviceaccount my-service-account

2.5.1.63. oc create user

사용자를 수동으로 생성 (자동 생성이 비활성화된 경우에만 필요)

사용 예

# Create a user with the username "ajones" and the display name "Adam Jones" oc create user ajones --full-name="Adam Jones"

2.5.1.64. oc create useridentitymapping

ID를 사용자에게 수동으로 매핑

사용 예

# Map the identity "acme_ldap:adamjones" to the user "ajones" oc create useridentitymapping acme_ldap:adamjones ajones

2.5.1.65. oc debug

디버깅을 위해 Pod의 새 인스턴스를 시작

사용 예

# Start a shell session into a pod using the OpenShift tools image oc debug # Debug a currently running deployment by creating a new pod oc debug deploy/test # Debug a node as an administrator oc debug node/master-1 # Launch a shell in a pod using the provided image stream tag oc debug istag/mysql:latest -n openshift # Test running a job as a non-root user oc debug job/test --as-user=1000000 # Debug a specific failing container by running the env command in the 'second' container oc debug daemonset/test -c second -- /bin/env # See the pod that would be created to debug oc debug mypod-9xbc -o yaml # Debug a resource but launch the debug pod in another namespace # Note: Not all resources can be debugged using --to-namespace without modification. For example, # volumes and service accounts are namespace-dependent. Add '-o yaml' to output the debug pod definition # to disk. If necessary, edit the definition then run 'oc debug -f -' or run without --to-namespace oc debug mypod-9xbc --to-namespace testns

2.5.1.66. oc delete

파일 이름, stdin, 리소스 및 이름별 또는 리소스 및 레이블 선택기별 리소스를 삭제

사용 예

# Delete a pod using the type and name specified in pod.json. oc delete -f ./pod.json # Delete resources from a directory containing kustomization.yaml - e.g. dir/kustomization.yaml. oc delete -k dir # Delete a pod based on the type and name in the JSON passed into stdin. cat pod.json | oc delete -f - # Delete pods and services with same names "baz" and "foo" oc delete pod,service baz foo # Delete pods and services with label name=myLabel. oc delete pods,services -l name=myLabel # Delete a pod with minimal delay oc delete pod foo --now # Force delete a pod on a dead node oc delete pod foo --force # Delete all pods oc delete pods --all

2.5.1.67. oc describe

특정 리소스 또는 리소스 그룹의 세부 정보를 표시

사용 예

# Describe a node oc describe nodes kubernetes-node-emt8.c.myproject.internal # Describe a pod oc describe pods/nginx # Describe a pod identified by type and name in "pod.json" oc describe -f pod.json # Describe all pods oc describe pods # Describe pods by label name=myLabel oc describe po -l name=myLabel # Describe all pods managed by the 'frontend' replication controller (rc-created pods # get the name of the rc as a prefix in the pod the name). oc describe pods frontend

2.5.1.68. oc diff

적용될 버전에 대한 Diff 라이브 버전

사용 예

# Diff resources included in pod.json. oc diff -f pod.json # Diff file read from stdin cat service.yaml | oc diff -f -

2.5.1.69. oc edit

서버에서 리소스를 편집

사용 예

# Edit the service named 'docker-registry': oc edit svc/docker-registry # Use an alternative editor KUBE_EDITOR="nano" oc edit svc/docker-registry # Edit the job 'myjob' in JSON using the v1 API format: oc edit job.v1.batch/myjob -o json # Edit the deployment 'mydeployment' in YAML and save the modified config in its annotation: oc edit deployment/mydeployment -o yaml --save-config

2.5.1.70. oc ex dockergc

Docker 스토리지에서 공간을 확보하기 위해 가비지 컬렉션을 수행

사용 예

# Perform garbage collection with the default settings oc ex dockergc

2.5.1.71. oc exec

컨테이너에서 명령을 실행

사용 예

# Get output from running 'date' command from pod mypod, using the first container by default oc exec mypod -- date # Get output from running 'date' command in ruby-container from pod mypod oc exec mypod -c ruby-container -- date # Switch to raw terminal mode, sends stdin to 'bash' in ruby-container from pod mypod # and sends stdout/stderr from 'bash' back to the client oc exec mypod -c ruby-container -i -t -- bash -il # List contents of /usr from the first container of pod mypod and sort by modification time. # If the command you want to execute in the pod has any flags in common (e.g. -i), # you must use two dashes (--) to separate your command's flags/arguments. # Also note, do not surround your command and its flags/arguments with quotes # unless that is how you would execute it normally (i.e., do ls -t /usr, not "ls -t /usr"). oc exec mypod -i -t -- ls -t /usr # Get output from running 'date' command from the first pod of the deployment mydeployment, using the first container by default oc exec deploy/mydeployment -- date # Get output from running 'date' command from the first pod of the service myservice, using the first container by default oc exec svc/myservice -- date

2.5.1.72. oc explain

리소스 문서

사용 예

# Get the documentation of the resource and its fields oc explain pods # Get the documentation of a specific field of a resource oc explain pods.spec.containers

2.5.1.73. oc expose

복제된 애플리케이션을 서비스 또는 경로로 노출

사용 예

# Create a route based on service nginx. The new route will reuse nginx's labels oc expose service nginx # Create a route and specify your own label and route name oc expose service nginx -l name=myroute --name=fromdowntown # Create a route and specify a host name oc expose service nginx --hostname=www.example.com # Create a route with a wildcard oc expose service nginx --hostname=x.example.com --wildcard-policy=Subdomain # This would be equivalent to *.example.com. NOTE: only hosts are matched by the wildcard; subdomains would not be included # Expose a deployment configuration as a service and use the specified port oc expose dc ruby-hello-world --port=8080 # Expose a service as a route in the specified path oc expose service nginx --path=/nginx # Expose a service using different generators oc expose service nginx --name=exposed-svc --port=12201 --protocol="TCP" --generator="service/v2" oc expose service nginx --name=my-route --port=12201 --generator="route/v1" # Exposing a service using the "route/v1" generator (default) will create a new exposed route with the "--name" provided # (or the name of the service otherwise). You may not specify a "--protocol" or "--target-port" option when using this generator

2.5.1.74. oc extract

시크릿 또는 구성 맵을 디스크에 추출

사용 예

# Extract the secret "test" to the current directory oc extract secret/test # Extract the config map "nginx" to the /tmp directory oc extract configmap/nginx --to=/tmp # Extract the config map "nginx" to STDOUT oc extract configmap/nginx --to=- # Extract only the key "nginx.conf" from config map "nginx" to the /tmp directory oc extract configmap/nginx --to=/tmp --keys=nginx.conf

2.5.1.75. oc get

리소스를 하나 이상 표시

사용 예

# List all pods in ps output format.

oc get pods

# List all pods in ps output format with more information (such as node name).

oc get pods -o wide

# List a single replication controller with specified NAME in ps output format.

oc get replicationcontroller web

# List deployments in JSON output format, in the "v1" version of the "apps" API group:

oc get deployments.v1.apps -o json

# List a single pod in JSON output format.

oc get -o json pod web-pod-13je7

# List a pod identified by type and name specified in "pod.yaml" in JSON output format.

oc get -f pod.yaml -o json

# List resources from a directory with kustomization.yaml - e.g. dir/kustomization.yaml.

oc get -k dir/

# Return only the phase value of the specified pod.

oc get -o template pod/web-pod-13je7 --template={{.status.phase}}

# List resource information in custom columns.

oc get pod test-pod -o custom-columns=CONTAINER:.spec.containers[0].name,IMAGE:.spec.containers[0].image

# List all replication controllers and services together in ps output format.

oc get rc,services

# List one or more resources by their type and names.

oc get rc/web service/frontend pods/web-pod-13je7

2.5.1.76. oc idle

확장 가능한 리소스를 유휴 상태로 설정

사용 예

# Idle the scalable controllers associated with the services listed in to-idle.txt $ oc idle --resource-names-file to-idle.txt

2.5.1.77. oc image append

이미지에 레이어를 추가하고 레지스트리에 푸시

사용 예

# Remove the entrypoint on the mysql:latest image

oc image append --from mysql:latest --to myregistry.com/myimage:latest --image '{"Entrypoint":null}'

# Add a new layer to the image

oc image append --from mysql:latest --to myregistry.com/myimage:latest layer.tar.gz

# Add a new layer to the image and store the result on disk

# This results in $(pwd)/v2/mysql/blobs,manifests

oc image append --from mysql:latest --to file://mysql:local layer.tar.gz

# Add a new layer to the image and store the result on disk in a designated directory

# This will result in $(pwd)/mysql-local/v2/mysql/blobs,manifests

oc image append --from mysql:latest --to file://mysql:local --dir mysql-local layer.tar.gz

# Add a new layer to an image that is stored on disk (~/mysql-local/v2/image exists)

oc image append --from-dir ~/mysql-local --to myregistry.com/myimage:latest layer.tar.gz

# Add a new layer to an image that was mirrored to the current directory on disk ($(pwd)/v2/image exists)

oc image append --from-dir v2 --to myregistry.com/myimage:latest layer.tar.gz

# Add a new layer to a multi-architecture image for an os/arch that is different from the system's os/arch

# Note: Wildcard filter is not supported with append. Pass a single os/arch to append

oc image append --from docker.io/library/busybox:latest --filter-by-os=linux/s390x --to myregistry.com/myimage:latest layer.tar.gz

2.5.1.78. oc image extract

이미지에서 파일 시스템으로 파일을 복사

사용 예

# Extract the busybox image into the current directory oc image extract docker.io/library/busybox:latest # Extract the busybox image into a designated directory (must exist) oc image extract docker.io/library/busybox:latest --path /:/tmp/busybox # Extract the busybox image into the current directory for linux/s390x platform # Note: Wildcard filter is not supported with extract. Pass a single os/arch to extract oc image extract docker.io/library/busybox:latest --filter-by-os=linux/s390x # Extract a single file from the image into the current directory oc image extract docker.io/library/centos:7 --path /bin/bash:. # Extract all .repo files from the image's /etc/yum.repos.d/ folder into the current directory oc image extract docker.io/library/centos:7 --path /etc/yum.repos.d/*.repo:. # Extract all .repo files from the image's /etc/yum.repos.d/ folder into a designated directory (must exist) # This results in /tmp/yum.repos.d/*.repo on local system oc image extract docker.io/library/centos:7 --path /etc/yum.repos.d/*.repo:/tmp/yum.repos.d # Extract an image stored on disk into the current directory ($(pwd)/v2/busybox/blobs,manifests exists) # --confirm is required because the current directory is not empty oc image extract file://busybox:local --confirm # Extract an image stored on disk in a directory other than $(pwd)/v2 into the current directory # --confirm is required because the current directory is not empty ($(pwd)/busybox-mirror-dir/v2/busybox exists) oc image extract file://busybox:local --dir busybox-mirror-dir --confirm # Extract an image stored on disk in a directory other than $(pwd)/v2 into a designated directory (must exist) oc image extract file://busybox:local --dir busybox-mirror-dir --path /:/tmp/busybox # Extract the last layer in the image oc image extract docker.io/library/centos:7[-1] # Extract the first three layers of the image oc image extract docker.io/library/centos:7[:3] # Extract the last three layers of the image oc image extract docker.io/library/centos:7[-3:]

2.5.1.79. oc image info

이미지에 대한 정보 표시

사용 예

# Show information about an image oc image info quay.io/openshift/cli:latest # Show information about images matching a wildcard oc image info quay.io/openshift/cli:4.* # Show information about a file mirrored to disk under DIR oc image info --dir=DIR file://library/busybox:latest # Select which image from a multi-OS image to show oc image info library/busybox:latest --filter-by-os=linux/arm64

2.5.1.80. oc image mirror

한 저장소에서 다른 저장소로 이미지를 미러링

사용 예

# Copy image to another tag oc image mirror myregistry.com/myimage:latest myregistry.com/myimage:stable # Copy image to another registry oc image mirror myregistry.com/myimage:latest docker.io/myrepository/myimage:stable # Copy all tags starting with mysql to the destination repository oc image mirror myregistry.com/myimage:mysql* docker.io/myrepository/myimage # Copy image to disk, creating a directory structure that can be served as a registry oc image mirror myregistry.com/myimage:latest file://myrepository/myimage:latest # Copy image to S3 (pull from <bucket>.s3.amazonaws.com/image:latest) oc image mirror myregistry.com/myimage:latest s3://s3.amazonaws.com/<region>/<bucket>/image:latest # Copy image to S3 without setting a tag (pull via @<digest>) oc image mirror myregistry.com/myimage:latest s3://s3.amazonaws.com/<region>/<bucket>/image # Copy image to multiple locations oc image mirror myregistry.com/myimage:latest docker.io/myrepository/myimage:stable \ docker.io/myrepository/myimage:dev # Copy multiple images oc image mirror myregistry.com/myimage:latest=myregistry.com/other:test \ myregistry.com/myimage:new=myregistry.com/other:target # Copy manifest list of a multi-architecture image, even if only a single image is found oc image mirror myregistry.com/myimage:latest=myregistry.com/other:test \ --keep-manifest-list=true # Copy specific os/arch manifest of a multi-architecture image # Run 'oc image info myregistry.com/myimage:latest' to see available os/arch for multi-arch images # Note that with multi-arch images, this results in a new manifest list digest that includes only # the filtered manifests oc image mirror myregistry.com/myimage:latest=myregistry.com/other:test \ --filter-by-os=os/arch # Copy all os/arch manifests of a multi-architecture image # Run 'oc image info myregistry.com/myimage:latest' to see list of os/arch manifests that will be mirrored oc image mirror myregistry.com/myimage:latest=myregistry.com/other:test \ --keep-manifest-list=true # Note the above command is equivalent to oc image mirror myregistry.com/myimage:latest=myregistry.com/other:test \ --filter-by-os=.*

2.5.1.81. oc import-image

컨테이너 이미지 레지스트리에서 이미지를 가져옵니다

사용 예

# Import tag latest into a new image stream oc import-image mystream --from=registry.io/repo/image:latest --confirm # Update imported data for tag latest in an already existing image stream oc import-image mystream # Update imported data for tag stable in an already existing image stream oc import-image mystream:stable # Update imported data for all tags in an existing image stream oc import-image mystream --all # Import all tags into a new image stream oc import-image mystream --from=registry.io/repo/image --all --confirm # Import all tags into a new image stream using a custom timeout oc --request-timeout=5m import-image mystream --from=registry.io/repo/image --all --confirm

2.5.1.82. oc kustomize

디렉터리 또는 URL에서 kustomization 대상을 빌드

사용 예

# Build the current working directory oc kustomize # Build some shared configuration directory oc kustomize /home/config/production # Build from github oc kustomize https://github.com/kubernetes-sigs/kustomize.git/examples/helloWorld?ref=v1.0.6

2.5.1.83. oc label

리소스에서 레이블을 업데이트

사용 예

# Update pod 'foo' with the label 'unhealthy' and the value 'true'. oc label pods foo unhealthy=true # Update pod 'foo' with the label 'status' and the value 'unhealthy', overwriting any existing value. oc label --overwrite pods foo status=unhealthy # Update all pods in the namespace oc label pods --all status=unhealthy # Update a pod identified by the type and name in "pod.json" oc label -f pod.json status=unhealthy # Update pod 'foo' only if the resource is unchanged from version 1. oc label pods foo status=unhealthy --resource-version=1 # Update pod 'foo' by removing a label named 'bar' if it exists. # Does not require the --overwrite flag. oc label pods foo bar-

2.5.1.84. oc login

서버에 로그인

사용 예

# Log in interactively oc login --username=myuser # Log in to the given server with the given certificate authority file oc login localhost:8443 --certificate-authority=/path/to/cert.crt # Log in to the given server with the given credentials (will not prompt interactively) oc login localhost:8443 --username=myuser --password=mypass

2.5.1.85. oc logout

현재 서버 세션을 종료

사용 예

# Log out oc logout

2.5.1.86. oc logs

Pod에서 컨테이너의 로그를 출력

사용 예

# Start streaming the logs of the most recent build of the openldap build config oc logs -f bc/openldap # Start streaming the logs of the latest deployment of the mysql deployment config oc logs -f dc/mysql # Get the logs of the first deployment for the mysql deployment config. Note that logs # from older deployments may not exist either because the deployment was successful # or due to deployment pruning or manual deletion of the deployment oc logs --version=1 dc/mysql # Return a snapshot of ruby-container logs from pod backend oc logs backend -c ruby-container # Start streaming of ruby-container logs from pod backend oc logs -f pod/backend -c ruby-container

2.5.1.87. oc new-app

새 애플리케이션을 생성

사용 예

# List all local templates and image streams that can be used to create an app oc new-app --list # Create an application based on the source code in the current git repository (with a public remote) and a Docker image oc new-app . --docker-image=registry/repo/langimage # Create an application myapp with Docker based build strategy expecting binary input oc new-app --strategy=docker --binary --name myapp # Create a Ruby application based on the provided [image]~[source code] combination oc new-app centos/ruby-25-centos7~https://github.com/sclorg/ruby-ex.git # Use the public Docker Hub MySQL image to create an app. Generated artifacts will be labeled with db=mysql oc new-app mysql MYSQL_USER=user MYSQL_PASSWORD=pass MYSQL_DATABASE=testdb -l db=mysql # Use a MySQL image in a private registry to create an app and override application artifacts' names oc new-app --docker-image=myregistry.com/mycompany/mysql --name=private # Create an application from a remote repository using its beta4 branch oc new-app https://github.com/openshift/ruby-hello-world#beta4 # Create an application based on a stored template, explicitly setting a parameter value oc new-app --template=ruby-helloworld-sample --param=MYSQL_USER=admin # Create an application from a remote repository and specify a context directory oc new-app https://github.com/youruser/yourgitrepo --context-dir=src/build # Create an application from a remote private repository and specify which existing secret to use oc new-app https://github.com/youruser/yourgitrepo --source-secret=yoursecret # Create an application based on a template file, explicitly setting a parameter value oc new-app --file=./example/myapp/template.json --param=MYSQL_USER=admin # Search all templates, image streams, and Docker images for the ones that match "ruby" oc new-app --search ruby # Search for "ruby", but only in stored templates (--template, --image-stream and --docker-image # can be used to filter search results) oc new-app --search --template=ruby # Search for "ruby" in stored templates and print the output as YAML oc new-app --search --template=ruby --output=yaml

2.5.1.88. oc new-build

새 빌드 구성을 생성

사용 예

# Create a build config based on the source code in the current git repository (with a public # remote) and a Docker image oc new-build . --docker-image=repo/langimage # Create a NodeJS build config based on the provided [image]~[source code] combination oc new-build centos/nodejs-8-centos7~https://github.com/sclorg/nodejs-ex.git # Create a build config from a remote repository using its beta2 branch oc new-build https://github.com/openshift/ruby-hello-world#beta2 # Create a build config using a Dockerfile specified as an argument oc new-build -D $'FROM centos:7\nRUN yum install -y httpd' # Create a build config from a remote repository and add custom environment variables oc new-build https://github.com/openshift/ruby-hello-world -e RACK_ENV=development # Create a build config from a remote private repository and specify which existing secret to use oc new-build https://github.com/youruser/yourgitrepo --source-secret=yoursecret # Create a build config from a remote repository and inject the npmrc into a build oc new-build https://github.com/openshift/ruby-hello-world --build-secret npmrc:.npmrc # Create a build config from a remote repository and inject environment data into a build oc new-build https://github.com/openshift/ruby-hello-world --build-config-map env:config # Create a build config that gets its input from a remote repository and another Docker image oc new-build https://github.com/openshift/ruby-hello-world --source-image=openshift/jenkins-1-centos7 --source-image-path=/var/lib/jenkins:tmp

2.5.1.89. oc new-project

새 프로젝트를 요청

사용 예

# Create a new project with minimal information oc new-project web-team-dev # Create a new project with a display name and description oc new-project web-team-dev --display-name="Web Team Development" --description="Development project for the web team."

2.5.1.90. oc observe

리소스에 대한 변경 사항을 관찰하고 이에 대응합니다(시험적)

사용 예

# Observe changes to services

oc observe services

# Observe changes to services, including the clusterIP and invoke a script for each

oc observe services --template '{ .spec.clusterIP }' -- register_dns.sh

# Observe changes to services filtered by a label selector

oc observe namespaces -l regist-dns=true --template '{ .spec.clusterIP }' -- register_dns.sh

2.5.1.91. oc patch

리소스 필드를 업데이트

사용 예

# Partially update a node using a strategic merge patch. Specify the patch as JSON.

oc patch node k8s-node-1 -p '{"spec":{"unschedulable":true}}'

# Partially update a node using a strategic merge patch. Specify the patch as YAML.

oc patch node k8s-node-1 -p $'spec:\n unschedulable: true'

# Partially update a node identified by the type and name specified in "node.json" using strategic merge patch.

oc patch -f node.json -p '{"spec":{"unschedulable":true}}'

# Update a container's image; spec.containers[*].name is required because it's a merge key.

oc patch pod valid-pod -p '{"spec":{"containers":[{"name":"kubernetes-serve-hostname","image":"new image"}]}}'

# Update a container's image using a json patch with positional arrays.

oc patch pod valid-pod --type='json' -p='[{"op": "replace", "path": "/spec/containers/0/image", "value":"new image"}]'

2.5.1.92. oc policy add-role-to-user

현재 프로젝트의 사용자 또는 서비스 계정에 역할을 추가

사용 예

# Add the 'view' role to user1 for the current project oc policy add-role-to-user view user1 # Add the 'edit' role to serviceaccount1 for the current project oc policy add-role-to-user edit -z serviceaccount1

2.5.1.93. oc policy scc-review

Pod를 생성할 수 있는 서비스 계정을 확인

사용 예

# Check whether service accounts sa1 and sa2 can admit a pod with a template pod spec specified in my_resource.yaml # Service Account specified in myresource.yaml file is ignored oc policy scc-review -z sa1,sa2 -f my_resource.yaml # Check whether service accounts system:serviceaccount:bob:default can admit a pod with a template pod spec specified in my_resource.yaml oc policy scc-review -z system:serviceaccount:bob:default -f my_resource.yaml # Check whether the service account specified in my_resource_with_sa.yaml can admit the pod oc policy scc-review -f my_resource_with_sa.yaml # Check whether the default service account can admit the pod; default is taken since no service account is defined in myresource_with_no_sa.yaml oc policy scc-review -f myresource_with_no_sa.yaml

2.5.1.94. oc policy scc-subject-review

사용자 또는 서비스 계정의 Pod 생성 가능 여부 확인

사용 예

# Check whether user bob can create a pod specified in myresource.yaml oc policy scc-subject-review -u bob -f myresource.yaml # Check whether user bob who belongs to projectAdmin group can create a pod specified in myresource.yaml oc policy scc-subject-review -u bob -g projectAdmin -f myresource.yaml # Check whether a service account specified in the pod template spec in myresourcewithsa.yaml can create the pod oc policy scc-subject-review -f myresourcewithsa.yaml

2.5.1.95. oc port-forward

Pod에 하나 이상의 로컬 포트를 전달

사용 예

# Listen on ports 5000 and 6000 locally, forwarding data to/from ports 5000 and 6000 in the pod oc port-forward pod/mypod 5000 6000 # Listen on ports 5000 and 6000 locally, forwarding data to/from ports 5000 and 6000 in a pod selected by the deployment oc port-forward deployment/mydeployment 5000 6000 # Listen on port 8443 locally, forwarding to the targetPort of the service's port named "https" in a pod selected by the service oc port-forward service/myservice 8443:https # Listen on port 8888 locally, forwarding to 5000 in the pod oc port-forward pod/mypod 8888:5000 # Listen on port 8888 on all addresses, forwarding to 5000 in the pod oc port-forward --address 0.0.0.0 pod/mypod 8888:5000 # Listen on port 8888 on localhost and selected IP, forwarding to 5000 in the pod oc port-forward --address localhost,10.19.21.23 pod/mypod 8888:5000 # Listen on a random port locally, forwarding to 5000 in the pod oc port-forward pod/mypod :5000

2.5.1.96. oc process

템플릿을 리소스 목록으로 처리

사용 예

# Convert the template.json file into a resource list and pass to create oc process -f template.json | oc create -f - # Process a file locally instead of contacting the server oc process -f template.json --local -o yaml # Process template while passing a user-defined label oc process -f template.json -l name=mytemplate # Convert a stored template into a resource list oc process foo # Convert a stored template into a resource list by setting/overriding parameter values oc process foo PARM1=VALUE1 PARM2=VALUE2 # Convert a template stored in different namespace into a resource list oc process openshift//foo # Convert template.json into a resource list cat template.json | oc process -f -

2.5.1.97. oc project

다른 프로젝트로 전환

사용 예

# Switch to the 'myapp' project oc project myapp # Display the project currently in use oc project

2.5.1.98. oc projects

기존 프로젝트를 표시

사용 예

# List all projects oc projects

2.5.1.99. oc proxy

Kubernetes API 서버에 대해 프록시를 실행

사용 예

# To proxy all of the kubernetes api and nothing else. oc proxy --api-prefix=/ # To proxy only part of the kubernetes api and also some static files. # You can get pods info with 'curl localhost:8001/api/v1/pods' oc proxy --www=/my/files --www-prefix=/static/ --api-prefix=/api/ # To proxy the entire kubernetes api at a different root. # You can get pods info with 'curl localhost:8001/custom/api/v1/pods' oc proxy --api-prefix=/custom/ # Run a proxy to kubernetes apiserver on port 8011, serving static content from ./local/www/ oc proxy --port=8011 --www=./local/www/ # Run a proxy to kubernetes apiserver on an arbitrary local port. # The chosen port for the server will be output to stdout. oc proxy --port=0 # Run a proxy to kubernetes apiserver, changing the api prefix to k8s-api # This makes e.g. the pods api available at localhost:8001/k8s-api/v1/pods/ oc proxy --api-prefix=/k8s-api

2.5.1.100. oc registry info

통합 레지스트리에 대한 정보를 인쇄

사용 예

# Display information about the integrated registry oc registry info

2.5.1.101. oc registry login

통합 레지스트리에 로그인

사용 예

# Log in to the integrated registry oc registry login # Log in as the default service account in the current namespace oc registry login -z default # Log in to different registry using BASIC auth credentials oc registry login --registry quay.io/myregistry --auth-basic=USER:PASS

2.5.1.102. oc replace

리소스를 파일 이름 또는 stdin으로 교체

사용 예

# Replace a pod using the data in pod.json. oc replace -f ./pod.json # Replace a pod based on the JSON passed into stdin. cat pod.json | oc replace -f - # Update a single-container pod's image version (tag) to v4 oc get pod mypod -o yaml | sed 's/\(image: myimage\):.*$/\1:v4/' | oc replace -f - # Force replace, delete and then re-create the resource oc replace --force -f ./pod.json

2.5.1.103. oc rollback

애플리케이션의 일부를 이전 배포로 되돌립니다

사용 예