서비스 메시

서비스 메시 설치, 사용법, 릴리스 정보

초록

1장. 서비스 메시 2.x

1.1. OpenShift Service Mesh 정보

Red Hat OpenShift Service Mesh는 OpenShift Container Platform과 다른 주기로 출시되고 Red Hat OpenShift Service Mesh Operator가 ServiceMeshControlPlane 의 여러 버전 배포를 지원하므로 서비스 메시 문서는 제품의 마이너 버전에 대한 별도의 문서 세트를 유지 관리하지 않습니다. 현재 문서 세트는 특정 주제 또는 특정 기능에 대해 버전 관련 제한을 호출하지 않는 한 현재 지원되는 모든 버전의 Service Mesh에 적용됩니다.

Red Hat OpenShift Service Mesh 라이프 사이클 및 지원되는 플랫폼에 대한 자세한 내용은 플랫폼 라이프 사이클 정책을 참조하십시오.

1.1.1. Red Hat OpenShift Service Mesh 소개

Red Hat OpenShift Service Mesh는 애플리케이션에서 중앙 집중식 제어 지점을 생성하여 마이크로 서비스 아키텍처에서 다양한 문제에 대응합니다. 애플리케이션 코드를 변경하지 않고도 기존 분산 애플리케이션에 투명한 레이어를 추가합니다.

마이크로 서비스 아키텍처는 엔터프라이즈 애플리케이션의 작업을 모듈식 서비스로 분할하므로 확장 및 유지 관리를 더 쉽게 수행할 수 있습니다. 그러나 마이크로 서비스 아키텍처에 구축된 엔터프라이즈 애플리케이션이 크기와 복잡성이 증가함에 따라 마이크로 서비스 아키텍처의 이해 및 관리가 어려워집니다. 서비스 메시는 서비스 간 트래픽을 캡처하거나 차단하거나 다른 서비스에 대한 새 요청을 리디렉트 또는 생성하여 이러한 아키텍처의 문제에 대응할 수 있습니다.

오픈 소스 Istio project를 기반으로 하는 Service Mesh는 배포된 서비스 네트워크를 쉽게 구축할 수 있는 방법을 제공하여 검색, 로드 밸런싱, 서비스 간 인증, 실패 복구, 지표 및 모니터링을 지원합니다. 또한 서비스 메시는 A/B 테스트, 카나리아 릴리스, 액세스 제어, 엔드 투 엔드 인증을 비롯한 복잡한 운영 기능을 제공합니다.

1.1.2. 핵심 기능

Red Hat OpenShift Service Mesh는 서비스 네트워크 전반에서 여러 주요 기능을 균일하게 제공합니다.

- 트래픽 관리 - 서비스 간 트래픽 및 API 호출 흐름을 제어하고, 호출을 더 안정적으로 만들며, 불리한 조건에서도 네트워크를 보다 견고하게 만듭니다.

- 서비스 ID 및 보안 - 메시에서 확인 가능한 ID로 서비스를 제공하고 다양한 수준의 신뢰도를 갖춘 네트워크를 통해 전달될 때 서비스 트래픽을 보호할 수 있는 기능을 제공합니다.

- 정책 강화- 서비스 간 상호 작용에 조직 정책을 적용하여 액세스 정책이 시행되고 리소스가 소비자 간에 공정하게 배포되도록 합니다. 애플리케이션 코드를 변경하는 것이 아니라 메시를 구성하여 정책 변경을 수행합니다.

- Telemetry - 서비스 간의 종속성과 트래픽 속성 및 흐름을 이해하여 문제를 신속하게 식별할 수 있는 기능을 제공합니다.

1.2. 서비스 메시 릴리스 노트

1.2.1. 보다 포괄적 수용을 위한 오픈 소스 용어 교체

Red Hat은 코드, 문서, 웹 속성에서 문제가 있는 용어를 교체하기 위해 최선을 다하고 있습니다. 먼저 마스터(master), 슬레이브(slave), 블랙리스트(blacklist), 화이트리스트(whitelist) 등 네 가지 용어를 교체하고 있습니다. 이러한 변경 작업은 작업 범위가 크므로 향후 여러 릴리스에 걸쳐 점차 구현할 예정입니다. 자세한 내용은 CTO Chris Wright의 메시지를 참조하십시오.

1.2.2. 새로운 기능 및 개선 사항

이 릴리스에는 다음 구성 요소 및 개념과 관련된 개선 사항이 추가되었습니다.

1.2.2.1. Red Hat OpenShift Service Mesh 버전 2.2.3 새 기능

이번 Red Hat OpenShift Service Mesh 릴리스는 CVE(Common Vulnerabilities and Exposures), 버그 수정, OpenShift Container Platform 4.9 이상에서 지원됩니다.

1.2.2.1.1. Red Hat OpenShift Service Mesh 버전 2.2.3에 포함된 구성 요소 버전

| 구성 요소 | 버전 |

|---|---|

| Istio | 1.12.9 |

| Envoy 프록시 | 1.20.8 |

| Jaeger | 1.36 |

| Kiali | 1.48.3 |

1.2.2.2. Red Hat OpenShift Service Mesh 버전 2.2.2 새 기능

이번 Red Hat OpenShift Service Mesh 릴리스는 CVE(Common Vulnerabilities and Exposures), 버그 수정, OpenShift Container Platform 4.9 이상에서 지원됩니다.

1.2.2.2.1. Red Hat OpenShift Service Mesh 버전 2.2.2에 포함된 구성 요소 버전

| 구성 요소 | 버전 |

|---|---|

| Istio | 1.12.7 |

| Envoy 프록시 | 1.20.6 |

| Jaeger | 1.36 |

| Kiali | 1.48.2-1 |

1.2.2.2.2. 경로 레이블 복사

이번 개선된 기능을 통해 주석 복사 외에도 OpenShift 경로의 특정 레이블을 복사할 수 있습니다. Red Hat OpenShift Service Mesh는 Istio Gateway 리소스에 있는 모든 레이블 및 주석( kubectl.kubernetes.io로 시작하는 주석 제외)을 관리형 OpenShift 경로 리소스에 복사합니다.

1.2.2.3. Red Hat OpenShift Service Mesh 버전 2.2.1 새 기능

이번 Red Hat OpenShift Service Mesh 릴리스는 CVE(Common Vulnerabilities and Exposures), 버그 수정, OpenShift Container Platform 4.9 이상에서 지원됩니다.

1.2.2.3.1. Red Hat OpenShift Service Mesh 버전 2.2.1에 포함된 구성 요소 버전

| 구성 요소 | 버전 |

|---|---|

| Istio | 1.12.7 |

| Envoy 프록시 | 1.20.6 |

| Jaeger | 1.34.1 |

| Kiali | 1.48.2-1 |

1.2.2.4. Red Hat OpenShift Service Mesh 2.2 새 기능

이번 Red Hat OpenShift Service Mesh 릴리스에는 새로운 기능 및 개선 사항이 추가되어 OpenShift Container Platform 4.9 이상에서 지원됩니다.

1.2.2.4.1. Red Hat OpenShift Service Mesh 버전 2.2에 포함된 구성 요소 버전

| 구성 요소 | 버전 |

|---|---|

| Istio | 1.12.7 |

| Envoy 프록시 | 1.20.4 |

| Jaeger | 1.34.1 |

| Kiali | 1.48.0.16 |

1.2.2.4.2. WasmPlugin API

이번 릴리스에서는 WasmPlugin API를 지원하고 ServiceMeshExtention API를 더 이상 사용하지 않습니다.

1.2.2.4.3. ROSA 지원

이번 릴리스에서는 다중 클러스터 페더레이션을 포함하여 AWS(ROSA)의 Red Hat OpenShift에 대한 서비스 메시 지원을 도입했습니다.

1.2.2.4.4. Istio-node DaemonSet의 이름

이번 릴리스에서는 istio-node DaemonSet이 업스트림 Istio의 이름과 일치하도록 istio-cni-node 로 이름이 변경되었습니다.

1.2.2.4.5. Envoy 사이드카 네트워킹 변경

Istio 1.10은 기본적으로 lo 대신 eth0 을 사용하여 애플리케이션 컨테이너로 트래픽을 전송하도록 Envoy를 업데이트했습니다.

1.2.2.4.6. 서비스 메시 컨트롤 플레인 1.1

이번 릴리스에서는 모든 플랫폼의 서비스 메시 1.1을 기반으로 서비스 메시 컨트롤 플레인에 대한 지원 종료를 표시합니다.

1.2.2.4.7. Istio 1.12 지원

서비스 메시 2.2는 Istio 1.12를 기반으로 하며 새로운 기능 및 제품 개선 사항을 제공합니다. 많은 Istio 1.12 기능이 지원되지만 다음과 같은 지원되지 않는 기능을 고려해야 합니다.

- AuthPolicy Dry Run은 기술 프리뷰 기능입니다.

- gRPC 프록시 없는 서비스 메시는 기술 프리뷰 기능입니다.

- Telemetry API는 기술 프리뷰 기능입니다.

- 검색 선택기는 지원되는 기능이 아닙니다.

- 외부 컨트롤 플레인은 지원되지 않습니다.

- 게이트웨이 삽입은 지원되는 기능이 아닙니다.

1.2.2.4.8. Kubernetes 게이트웨이 API

Kubernetes Gateway API는 기본적으로 비활성화되어 있는 기술 프리뷰 기능입니다.

기능을 활성화하려면 ServiceMeshControlPlane 에서 Istiod 컨테이너에 대해 다음 환경 변수를 설정합니다.

spec:

runtime:

components:

pilot:

container:

env:

PILOT_ENABLE_GATEWAY_API: true

PILOT_ENABLE_GATEWAY_API_STATUS: true

# and optionally, for the deployment controller

PILOT_ENABLE_GATEWAY_API_DEPLOYMENT_CONTROLLER: true

게이트웨이 API 리스너에 대한 경로 연결 제한은 SameNamespace 또는 All 설정을 사용하여 수행할 수 있습니다. Istio는 listeners.allowedRoutes.namespaces 의 라벨 선택기 사용을 무시하고 기본 동작(SameNamespace)으로 되돌립니다.

1.2.2.5. Red Hat OpenShift Service Mesh 2.1.5.1 새 기능

이번 Red Hat OpenShift Service Mesh 릴리스는 CVE(Common Vulnerabilities and Exposures), 버그 수정, OpenShift Container Platform 4.9 이상에서 지원됩니다.

1.2.2.5.1. Red Hat OpenShift Service Mesh 버전 2.1.5.1에 포함된 구성 요소 버전

| 구성 요소 | 버전 |

|---|---|

| Istio | 1.9.9 |

| Envoy 프록시 | 1.17.5 |

| Jaeger | 1.36 |

| Kiali | 1.36.13 |

1.2.2.6. Red Hat OpenShift Service Mesh 2.1.5 새 기능

이번 Red Hat OpenShift Service Mesh 릴리스는 CVE(Common Vulnerabilities and Exposures), 버그 수정, OpenShift Container Platform 4.9 이상에서 지원됩니다.

1.2.2.6.1. Red Hat OpenShift Service Mesh 버전 2.1.5에 포함된 구성 요소 버전

| 구성 요소 | 버전 |

|---|---|

| Istio | 1.9.9 |

| Envoy 프록시 | 1.17.1 |

| Jaeger | 1.36 |

| Kiali | 1.36.12-1 |

1.2.2.7. Red Hat OpenShift Service Mesh 2.1.4 새 기능

이번 Red Hat OpenShift Service Mesh 릴리스는 CVE(Common Vulnerabilities and Exposures) 및 버그 수정을 제공합니다.

1.2.2.7.1. Red Hat OpenShift Service Mesh 버전 2.1.4에 포함된 구성 요소 버전

| 구성 요소 | 버전 |

|---|---|

| Istio | 1.9.9 |

| Envoy 프록시 | 1.17.1 |

| Jaeger | 1.30.2 |

| Kiali | 1.36.12-1 |

1.2.2.8. Red Hat OpenShift Service Mesh 2.1.3 새 기능

이번 Red Hat OpenShift Service Mesh 릴리스는 CVE(Common Vulnerabilities and Exposures) 및 버그 수정을 제공합니다.

1.2.2.8.1. Red Hat OpenShift Service Mesh 버전 2.1.3에 포함된 구성 요소 버전

| 구성 요소 | 버전 |

|---|---|

| Istio | 1.9.9 |

| Envoy 프록시 | 1.17.1 |

| Jaeger | 1.30.2 |

| Kiali | 1.36.10-2 |

1.2.2.9. Red Hat OpenShift Service Mesh 2.1.2.1 새 기능

이번 Red Hat OpenShift Service Mesh 릴리스는 CVE(Common Vulnerabilities and Exposures) 및 버그 수정을 제공합니다.

1.2.2.9.1. Red Hat OpenShift Service Mesh 버전 2.1.2.1에 포함된 구성 요소 버전

| 구성 요소 | 버전 |

|---|---|

| Istio | 1.9.9 |

| Envoy 프록시 | 1.17.1 |

| Jaeger | 1.30.2 |

| Kiali | 1.36.9 |

1.2.2.10. Red Hat OpenShift Service Mesh 2.1.2 새 기능

이번 Red Hat OpenShift Service Mesh 릴리스는 CVE(Common Vulnerabilities and Exposures) 및 버그 수정을 제공합니다.

이번 릴리스에서는 Red Hat OpenShift distributed tracing platform Operator가 기본적으로 openshift-distributed-tracing 네임스페이스에 설치됩니다. 이전에는 기본 설치가 openshift-operator 네임스페이스에 있었습니다.

1.2.2.10.1. Red Hat OpenShift Service Mesh 버전 2.1.2에 포함된 구성 요소 버전

| 구성 요소 | 버전 |

|---|---|

| Istio | 1.9.9 |

| Envoy 프록시 | 1.17.1 |

| Jaeger | 1.30.1 |

| Kiali | 1.36.8 |

1.2.2.11. Red Hat OpenShift Service Mesh 2.1.1 새 기능

이번 Red Hat OpenShift Service Mesh 릴리스는 CVE(Common Vulnerabilities and Exposures) 및 버그 수정을 제공합니다.

이 릴리스에서는 네트워크 정책 자동 생성을 비활성화하는 기능도 추가되었습니다.

1.2.2.11.1. Red Hat OpenShift Service Mesh 버전 2.1.1에 포함된 구성 요소 버전

| 구성 요소 | 버전 |

|---|---|

| Istio | 1.9.9 |

| Envoy 프록시 | 1.17.1 |

| Jaeger | 1.24.1 |

| Kiali | 1.36.7 |

1.2.2.11.2. 네트워크 정책 비활성화

Red Hat OpenShift Service Mesh는 Service Mesh Control Plane 및 애플리케이션 네임스페이스에서 여러 NetworkPolicies 리소스를 자동으로 생성하고 관리합니다. 이는 애플리케이션과 컨트롤 플레인이 서로 통신할 수 있도록 하기 위한 것입니다.

예를 들어 회사 보안 정책을 적용하기 위해 NetworkPolicies 리소스의 자동 생성 및 관리를 비활성화하려면 이를 수행할 수 있습니다. ServiceMeshControlPlane 을 편집하여 spec.security.manageNetworkPolicy 설정을 false로 설정할 수 있습니다.

spec.security.manageNetworkPolicy Red Hat OpenShift Service Mesh를 비활성화하면 NetworkPolicy 오브젝트가 생성되지 않습니다. 시스템 관리자는 네트워크를 관리하고 이로 인해 발생할 수 있는 문제를 수정할 책임이 있습니다.

절차

- OpenShift Container Platform 웹 콘솔에서 Operator → 설치된 Operator를 클릭합니다.

-

프로젝트 메뉴에서 Service Mesh Control Plane을 설치한 프로젝트(예:

istio-system)를 선택합니다. -

Red Hat OpenShift Service Mesh Operator를 클릭합니다. Istio Service Mesh Control Plane 열에서

ServiceMeshControlPlane의 이름을 클릭합니다(예:basic-install). -

ServiceMeshControlPlane 세부 정보 만들기 페이지에서

YAML을 클릭하여 구성을 수정합니다. 이 예와 같이

ServiceMeshControlPlane필드spec.security.manageNetworkPolicy를false로 설정합니다.apiVersion: maistra.io/v2 kind: ServiceMeshControlPlane spec: security: trust: manageNetworkPolicy: false- 저장을 클릭합니다.

1.2.2.12. Red Hat OpenShift Service Mesh 2.1 새 기능 및 개선 사항

이번 Red Hat OpenShift Service Mesh 릴리스에는 OpenShift Container Platform 4.6 EUS, 4.7, 4.8, 4.9와 함께 Istio 1.9.8, Envoy 프록시 1.17.1, Jaeger 1.24.1 및 Kiali 1.36.5에 대한 지원이 추가되었습니다.

1.2.2.12.1. Red Hat OpenShift Service Mesh 버전 2.1에 포함된 구성 요소 버전

| 구성 요소 | 버전 |

|---|---|

| Istio | 1.9.6 |

| Envoy 프록시 | 1.17.1 |

| Jaeger | 1.24.1 |

| Kiali | 1.36.5 |

1.2.2.12.2. 서비스 메시 페더레이션

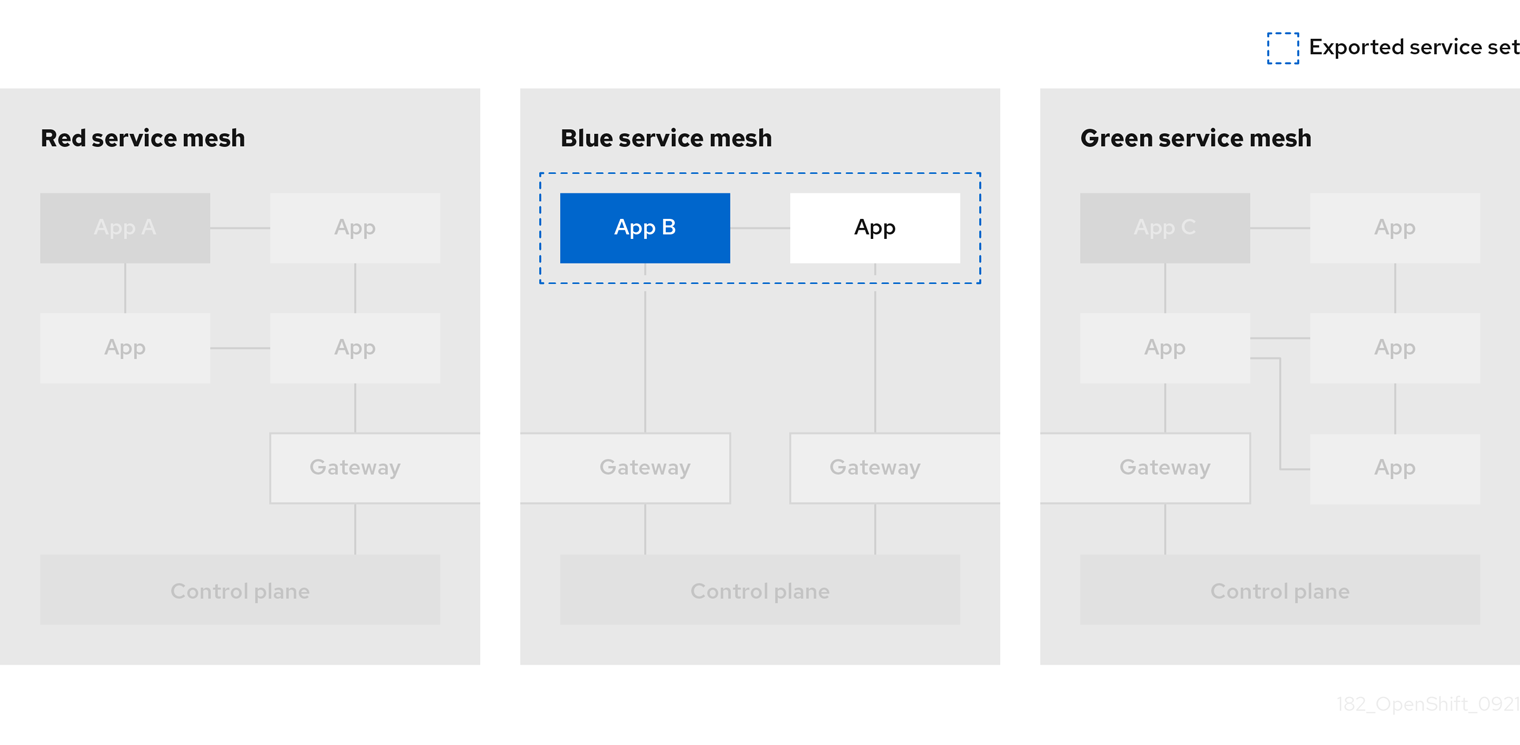

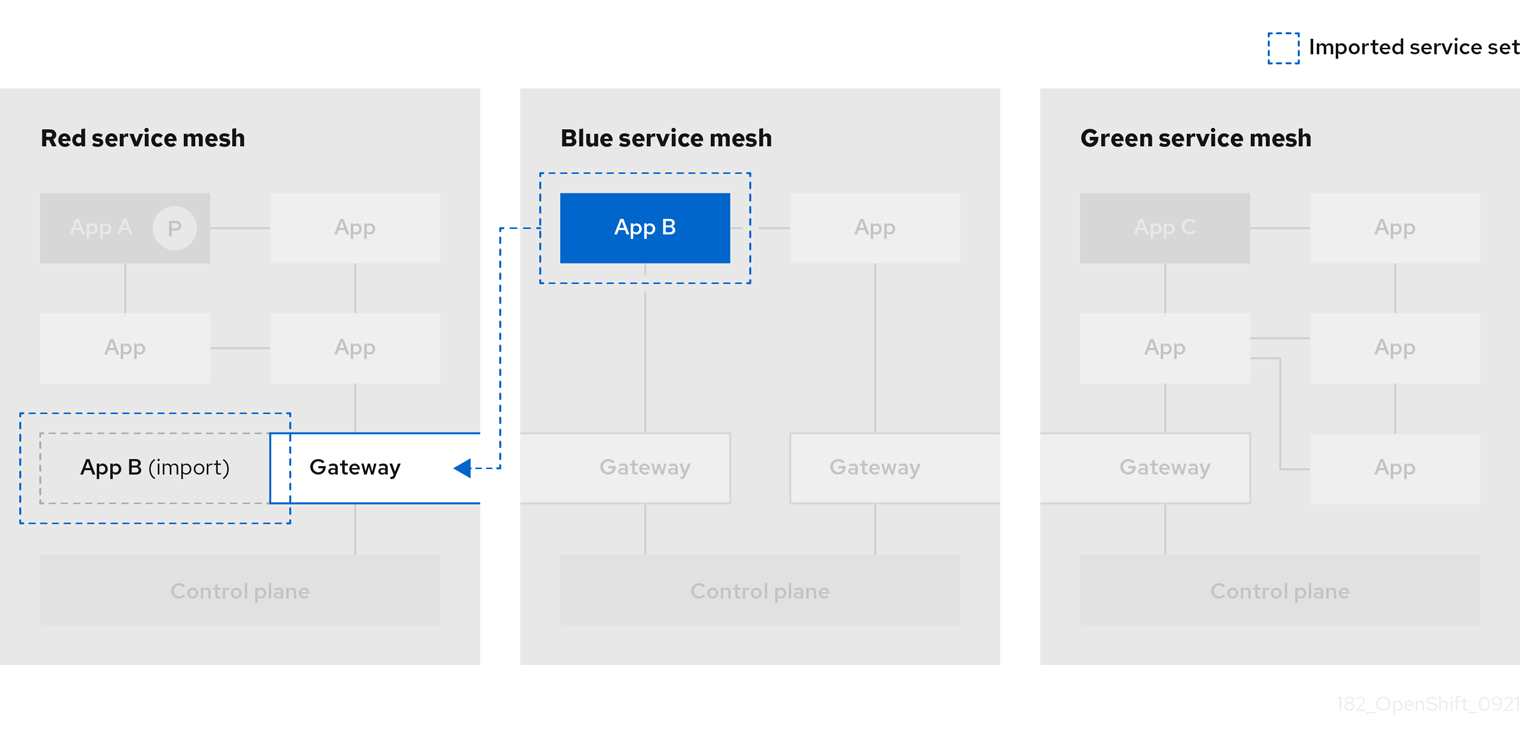

통합 서비스 메시를 지원하기 위해 새로운 CRD(Custom Resource Definitions)가 추가되었습니다. 동일한 클러스터 내에서 또는 다른 OpenShift 클러스터에서 서비스 메시를 모두 연결할 수 있습니다. 이러한 새 리소스는 다음과 같습니다.

-

ServiceMeshPeer- 게이트웨이 구성, 루트 신뢰 인증서 구성 및 상태 필드를 포함하여 별도의 서비스 메시와 페더레이션을 정의합니다. 연결된 메시 쌍에서 각 메시는 고유한 별도의ServiceMeshPeer리소스를 정의합니다. -

ExportedServiceMeshSet- 피어 메시에 사용할 수 있는 지정된ServiceMeshPeer의 서비스를 정의합니다. -

ImportedServiceSet- 피어 메시에서 가져온ServiceMeshPeer에 대한 서비스를 정의합니다. 이러한 서비스는 피어의 ExportedServiceMeshSet리소스에서도 사용할 수 있어야 합니다.

서비스 메시 페더레이션은 ROSA(Red Hat OpenShift Service on AWS), Azure Red Hat OpenShift(ARO) 또는 OSD(OpenShift Dedicated)의 클러스터 간에 지원되지 않습니다.

1.2.2.12.3. OVN-Kubernetes CNI(Container Network Interface) 일반적으로 사용 가능

OVN-Kubernetes CNI(Container Network Interface)는 이전에 Red Hat OpenShift Service Mesh 2.0.1에서 기술 프리뷰 기능으로 도입되었으며 OpenShift Container Platform 4.7.32, OpenShift Container Platform 4.8.12 및 OpenShift Container Platform 4.9에서 일반적으로 Red Hat OpenShift Service Mesh 2.1 및 2.0.x에서 사용할 수 있습니다.

1.2.2.12.4. Service Mesh WebAssembly (WASM) 확장

2.0에서 기술 프리뷰로 처음 도입된 ServiceMeshExtensions CRD(Custom Resource Definition)를 이제 일반적으로 사용할 수 있습니다. CRD를 사용하여 고유한 플러그인을 빌드할 수 있지만 Red Hat은 사용자가 생성한 플러그인을 지원하지 않습니다.

Mixer는 Service Mesh 2.1에서 완전히 제거되었습니다. Mixer가 활성화된 경우 Service Mesh 2.0.x 릴리스에서 2.1로 업그레이드가 차단됩니다. Mixer 플러그인은 WebAssembly 확장에 포팅되어야 합니다.

1.2.2.12.5. 3scale WebAssembly Adapter (WASM)

Mixer가 공식적으로 제거된 상태에서 OpenShift Service Mesh 2.1은 3scale Mix 어댑터를 지원하지 않습니다. Service Mesh 2.1으로 업그레이드하기 전에 Mixer 기반 3scale 어댑터 및 추가 Mixer 플러그인을 제거하십시오. 그런 다음 ServiceMeshExtension 리소스를 사용하여 Service Mesh 2.1+를 사용하여 새 3scale WebAssembly 어댑터를 수동으로 설치하고 구성합니다.

3scale 2.11에는 WebAssembly 를 기반으로 업데이트된 Service Mesh 통합이 도입되었습니다.

1.2.2.12.6. Istio 1.9 지원

Service Mesh 2.1은 Istio 1.9를 기반으로 하며 많은 수의 새로운 기능과 제품 개선 사항을 제공합니다. 대부분의 Istio 1.9 기능은 지원되지만 다음과 같은 예외에 유의해야 합니다.

- 가상 머신 통합이 아직 지원되지 않음

- Kubernetes 게이트웨이 API가 아직 지원되지 않음

- WebAssembly HTTP 필터의 원격 가져오기 및 로드는 아직 지원되지 않습니다.

- Kubernetes CSR API를 사용한 사용자 정의 CA 통합은 아직 지원되지 않습니다.

- 트래픽 모니터링을 위한 분류 요청은 기술 프리뷰 기능입니다.

- 권한 부여 정책의 CUSTOM 작업을 통해 외부 권한 부여 시스템과의 통합은 기술 검토 기능입니다.

1.2.2.12.7. 서비스 메시 Operator 성능 개선

Red Hat OpenShift Service Mesh에서 모든 ServiceMeshControlPlane 조정이 끝나면 이전 리소스를 정리하는 데 사용하는 시간이 줄어듭니다. 그러면 ServiceMeshControlPlane 배포 속도가 빨라지고 기존 SMCP에 적용된 변경 사항이 보다 신속하게 적용됩니다.

1.2.2.12.8. Kiali 업데이트

Kiali 1.36에는 다음과 같은 기능 및 개선 사항이 포함되어 있습니다.

서비스 메시 문제 해결 기능

- 컨트롤 플레인 및 게이트웨이 모니터링

- 프록시 동기화 상태

- Envoy 구성 뷰

- Envoy 프록시 및 애플리케이션 로그를 표시한 통합 보기

- 페더레이션 서비스 메시 보기를 지원하기 위한 네임스페이스 및 클러스터 박스

- 새로운 검증, 마법사 및 분산 추적 기능 개선 사항

1.2.2.13. Red Hat OpenShift Service Mesh 2.0.11.1 새 기능

이번 Red Hat OpenShift Service Mesh 릴리스는 CVE(Common Vulnerabilities and Exposures), 버그 수정, OpenShift Container Platform 4.9 이상에서 지원됩니다.

1.2.2.13.1. Red Hat OpenShift Service Mesh 버전 2.0.11.1에 포함된 구성 요소 버전

| 구성 요소 | 버전 |

|---|---|

| Istio | 1.6.14 |

| Envoy 프록시 | 1.14.5 |

| Jaeger | 1.36 |

| Kiali | 1.24.17 |

1.2.2.14. Red Hat OpenShift Service Mesh 2.0.11 새 기능

이번 Red Hat OpenShift Service Mesh 릴리스는 CVE(Common Vulnerabilities and Exposures), 버그 수정, OpenShift Container Platform 4.9 이상에서 지원됩니다.

1.2.2.14.1. Red Hat OpenShift Service Mesh 버전 2.0.11에 포함된 구성 요소 버전

| 구성 요소 | 버전 |

|---|---|

| Istio | 1.6.14 |

| Envoy 프록시 | 1.14.5 |

| Jaeger | 1.36 |

| Kiali | 1.24.16-1 |

1.2.2.15. Red Hat OpenShift Service Mesh 2.0.10 새 기능

이번 Red Hat OpenShift Service Mesh 릴리스는 CVE(Common Vulnerabilities and Exposures) 및 버그 수정을 제공합니다.

1.2.2.15.1. Red Hat OpenShift Service Mesh 버전 2.0.10에 포함된 구성 요소 버전

| 구성 요소 | 버전 |

|---|---|

| Istio | 1.6.14 |

| Envoy 프록시 | 1.14.5 |

| Jaeger | 1.28.0 |

| Kiali | 1.24.16-1 |

1.2.2.16. Red Hat OpenShift Service Mesh 2.0.9 새 기능

이번 Red Hat OpenShift Service Mesh 릴리스는 CVE(Common Vulnerabilities and Exposures) 및 버그 수정을 제공합니다.

1.2.2.16.1. Red Hat OpenShift Service Mesh 버전 2.0.9에 포함된 구성 요소 버전

| 구성 요소 | 버전 |

|---|---|

| Istio | 1.6.14 |

| Envoy 프록시 | 1.14.5 |

| Jaeger | 1.24.1 |

| Kiali | 1.24.11 |

1.2.2.17. Red Hat OpenShift Service Mesh 2.0.8 새 기능

이번 Red Hat OpenShift Service Mesh 릴리스는 버그 수정을 해결합니다.

1.2.2.18. Red Hat OpenShift Service Mesh 2.0.7.1 새 기능

이번 Red Hat OpenShift Service Mesh 릴리스는 CVE(Common Vulnerabilities and Exposures)를 제공합니다.

1.2.2.18.1. Red Hat OpenShift Service Mesh가 URI 내용을 처리하는 방법의 변경

Red Hat OpenShift Service Mesh에는 원격으로 악용할 수 있는 취약점 CVE-2021-39156 이 포함되어 있습니다. 여기서 URI 경로에 있는 URI 끝에 있는 HTTP 요청은 Istio URI 경로 기반 권한 부여 정책을 무시할 수 있습니다. 예를 들어 Istio 권한 부여 정책은 URI 경로 /user/profile 으로 전송된 요청을 거부합니다. 취약한 버전에서 URI 경로 /user/profile#section1 이 있는 요청은 거부 정책 및 경로를 백엔드로 무시합니다(정규화된 URI 경로 /user/profile%23section1사용) 보안 문제로 이어질 수 있습니다.

DENY 작업 및 operation.paths 또는 ALLOW 작업 및 operation. notPaths 와 함께 권한 부여 정책을 사용하는 경우 이 취약점의 영향을 받습니다.

완화를 통해 요청 URI의 조각 부분은 권한 부여 및 라우팅 전에 제거됩니다. 이렇게 하면 URI의 내용이 있는 요청이 조각 부분 없이 URI를 기반으로 하는 권한 부여 정책을 바이패스하지 않습니다.

완화의 새 동작을 옵트아웃하려면 URI의 fragment 섹션이 유지됩니다. URI 내용을 유지하도록 ServiceMeshControlPlane 을 구성할 수 있습니다.

새 동작을 비활성화하면 위에서 설명한 대로 경로를 정규화하고 안전하지 않은 것으로 간주됩니다. URI 내용을 유지하기 전에 모든 보안 정책에 사용할 수 있는지 확인합니다.

ServiceMeshControlPlane 수정 예

apiVersion: maistra.io/v2

kind: ServiceMeshControlPlane

metadata:

name: basic

spec:

techPreview:

meshConfig:

defaultConfig:

proxyMetadata: HTTP_STRIP_FRAGMENT_FROM_PATH_UNSAFE_IF_DISABLED: "false"

1.2.2.18.2. 권한 부여 정책에 필요한 업데이트

Istio는 호스트 이름 자체와 일치하는 포트 모두에 대한 호스트 이름을 생성합니다. 예를 들어 가상 서비스 또는 "httpbin.foo" 호스트의 게이트웨이는 "httpbin.foo 및 httpbin.foo:*"와 일치하는 구성을 생성합니다. 그러나 권한 부여 정책은 hosts 또는 notHosts 필드에 지정된 정확한 문자열과만 일치합니다.

호스트 또는 notHosts 를 결정하는 규칙에 대해 정확한 문자열 비교를 사용하여 AuthorizationPolicy 리소스가 있는 경우 클러스터가 영향을 받습니다.

정확한 일치 대신 접두사 일치를 사용하도록 권한 부여 정책 규칙을 업데이트해야 합니다. 예를 들어 첫 번째 AuthorizationPolicy 예제에서 ["httpbin.com"] 을 hosts: ["httpbin.com:*"] 로 교체합니다.

접두사 일치를 사용하는 첫 번째 예제 AuthorizationPolicy

apiVersion: security.istio.io/v1beta1

kind: AuthorizationPolicy

metadata:

name: httpbin

namespace: foo

spec:

action: DENY

rules:

- from:

- source:

namespaces: ["dev"]

to:

- operation:

hosts: [“httpbin.com”,"httpbin.com:*"]

접두사 일치를 사용하는 AuthorizationPolicy의 두 번째 예

apiVersion: security.istio.io/v1beta1

kind: AuthorizationPolicy

metadata:

name: httpbin

namespace: default

spec:

action: DENY

rules:

- to:

- operation:

hosts: ["httpbin.example.com:*"]

1.2.2.19. Red Hat OpenShift Service Mesh 2.0.7 새 기능

이번 Red Hat OpenShift Service Mesh 릴리스는 CVE(Common Vulnerabilities and Exposures) 및 버그 수정을 제공합니다.

1.2.2.20. Red Hat OpenShift Dedicated 및 Microsoft Azure Red Hat OpenShift의 Red Hat OpenShift Service Mesh

Red Hat OpenShift Service Mesh는 이제 Red Hat OpenShift Dedicated 및 Microsoft Azure Red Hat OpenShift를 통해 지원됩니다.

1.2.2.21. Red Hat OpenShift Service Mesh 2.0.6 새 기능

이번 Red Hat OpenShift Service Mesh 릴리스는 CVE(Common Vulnerabilities and Exposures) 및 버그 수정을 제공합니다.

1.2.2.22. Red Hat OpenShift Service Mesh 2.0.5 새 기능

이번 Red Hat OpenShift Service Mesh 릴리스는 CVE(Common Vulnerabilities and Exposures) 및 버그 수정을 제공합니다.

1.2.2.23. Red Hat OpenShift Service Mesh 2.0.4 새 기능

이번 Red Hat OpenShift Service Mesh 릴리스는 CVE(Common Vulnerabilities and Exposures) 및 버그 수정을 제공합니다.

CVE-2021-29492 및 CVE-2021-31920 문제를 해결하려면 수동 단계가 완료되어야 합니다.

1.2.2.23.1. CVE-2021-29492 및 CVE-2021-31920에서 필요한 수동 업데이트

Istio에는 경로 기반 권한 부여 규칙이 사용될 때 여러 슬래시 또는 이스케이프된 슬래시 문자(%2F 또는 %5C)가 있는 HTTP 요청 경로가 잠재적으로 Istio 권한 부여 정책을 우회할 수 있는 원격으로 악용 가능한 취약점이 포함되어 있습니다.

예를 들어 Istio 클러스터 관리자가 경로 /admin에 있는 요청을 거부하도록 권한 부여 DENY 정책을 정의한다고 가정합니다. //admin URL 경로에 전송된 요청이 권한 부여 정책에서 거부되지 않습니다.

RFC 3986에 따르면 여러 개의 슬래시가 있는 //admin 경로는 기술적으로 /admin과 다른 경로로 처리되어야 합니다. 그러나 일부 백엔드 서비스는 여러 슬래시를 단일 슬래시로 병합하여 URL 경로를 정규화하도록 선택합니다. 이로 인해 권한 부여 정책( //admin이 /admin과 일치하지 않음)을 우회할 수 있으며 사용자는 백엔드의 /admin 경로에 있는 리소스에 액세스할 수 있습니다. 결과적으로 이는 보안 문제로 나타날 수 있습니다.

ALLOW action + notPaths 필드 또는 DENY action + paths field 경로 필드 패턴을 사용하는 권한 부여 정책이 있는 경우 클러스터는 이 취약점의 영향을 받습니다. 이러한 패턴은 예기치 않은 정책 우회에 취약합니다.

다음과 같은 경우 클러스터는 이 취약점의 영향을 받지 않습니다.

- 권한 부여 정책이 없습니다.

-

권한 부여 정책은

paths또는notPaths필드를 정의하지 않습니다. -

권한 부여 정책은

ALLOW action + paths필드 또는DENY action + notPaths필드 패턴을 사용합니다. 이러한 패턴은 정책 우회 대신 예기치 않은 거부를 유발할 수 있습니다. 이러한 경우 업그레이드는 선택 사항입니다.

경로 정규화를 위한 Red Hat OpenShift Service Mesh 구성 위치는 Istio 구성과 다릅니다.

1.2.2.23.2. 경로 정규화 구성 업데이트

Istio 권한 부여 정책은 HTTP 요청의 URL 경로를 기반으로 할 수 있습니다. URI 정규화라고도 하는 경로 정규화는 들어오는 요청의 경로를 수정 및 표준화하여 정규화된 경로를 표준 방식으로 처리할 수 있도록 합니다. 구문적으로 경로 정규화 후에는 다른 경로가 동일할 수 있습니다.

Istio는 권한 부여 정책에 대해 평가하고 요청을 라우팅하기 전에 요청 경로에서 다음 정규화 체계를 지원합니다.

표 1.1. 정규화 체계

| 옵션 | 설명 | 예제 | 참고 |

|---|---|---|---|

|

| 정규화는 수행되지 않습니다. Envoy가 수신한 모든 항목은 정확히 그대로 모든 백엔드 서비스에 전달됩니다. |

| 이 설정은 CVE-2021-31920에 취약합니다. |

|

|

현재 이는 Istio의 기본 설치에 사용되는 옵션입니다. 이로 인해 Envoy 프록시에 |

| 이 설정은 CVE-2021-31920에 취약합니다. |

|

| BASE 정규화 후 슬래시가 병합됩니다. |

| CVE-2021-31920을 완화하려면 이 설정으로 업데이트합니다. |

|

|

기본적으로 모든 트래픽을 허용할 때 가장 엄격한 설정입니다. 이 설정은 권한 부여 정책 경로를 철저하게 테스트해야 한다는 경고와 함께 권장됩니다. 백분율로 인코딩된 슬래시 및 백슬래시 문자 ( |

| CVE-2021-31920을 완화하려면 이 설정으로 업데이트합니다. 이 설정은 더 안전하지만 애플리케이션이 중단될 수도 있습니다. 프로덕션에 배포하기 전에 애플리케이션을 테스트합니다. |

정규화 알고리즘은 다음 순서로 수행됩니다.

-

백분율로 디코딩된

%2F,%2f,%5C및%5c. -

Envoy의

normalize_path옵션에 의해 구현된 RFC 3986 및 기타 정규화입니다. - 슬래시를 병합합니다.

이러한 정규화 옵션은 HTTP 표준 및 일반적인 업계 관행의 권장 사항을 나타내지만 애플리케이션은 원하는 방식으로 URL을 해석할 수 있습니다. 거부 정책을 사용할 때 애플리케이션이 작동하는 방식을 이해해야 합니다.

1.2.2.23.3. 경로 정규화 구성 예

Envoy는 백엔드 서비스의 기대치와 일치하도록 요청 경로를 표준화하여 시스템 보안에 매우 중요합니다. 다음 예제는 시스템을 구성하기 위한 참조로 사용할 수 있습니다. 정규화된 URL 경로 또는 NONE이 선택된 경우 원래 URL 경로는 다음과 같습니다.

- 권한 부여 정책을 확인하는 데 사용됩니다.

- 백엔드 애플리케이션으로 전달됩니다.

표 1.2. 구성 예

| 애플리케이션 조건 | 선택… |

|---|---|

| 프록시를 사용하여 정규화를 수행합니다. |

|

| RFC 3986을 기반으로 요청 경로를 정규화하고 슬래시를 병합하지 않습니다. |

|

| RFC 3986을 기반으로 요청 경로를 정규화하고 슬래시를 병합하지만 백분율로 인코딩된 슬래시를 디코딩하지는 않습니다. |

|

| RFC 3986을 기반으로 요청 경로를 표준화하고, 백분율로 인코딩된 슬래시를 디코딩하고, 슬래시를 병합합니다. |

|

| 프로세스는 RFC 3986과 호환되지 않는 방식으로 요청 경로를 처리합니다. |

|

1.2.2.23.4. 경로 정규화를 위해 SMCP 구성

Red Hat OpenShift Service Mesh에 대한 경로 정규화를 구성하려면 ServiceMeshControlPlane에서 다음을 지정합니다. 시스템 설정을 결정하는 데 도움이 되도록 구성 예제를 사용합니다.

SMCP v2 pathNormalization

spec:

techPreview:

global:

pathNormalization: <option>

1.2.2.23.5. 케이스 정규화를 위한 설정

일부 환경에서는 대/소문자를 구분하지 않는 권한 부여 정책의 경로를 사용하는 것이 유용할 수 있습니다. 예를 들어 https://myurl/get 및 https://myurl/GeT을 동일한 방법으로 처리합니다. 이 경우 아래에 표시된 EnvoyFilter를 사용할 수 있습니다. 이 필터는 비교에 사용되는 경로와 애플리케이션에 제공되는 경로를 모두 변경합니다. 이 예제에서 istio-system 은 Service Mesh Control Plane 프로젝트의 이름입니다.

EnvoyFilter 를 파일에 저장하고 다음 명령을 실행합니다.

$ oc create -f <myEnvoyFilterFile>

apiVersion: networking.istio.io/v1alpha3

kind: EnvoyFilter

metadata:

name: ingress-case-insensitive

namespace: istio-system

spec:

configPatches:

- applyTo: HTTP_FILTER

match:

context: GATEWAY

listener:

filterChain:

filter:

name: "envoy.filters.network.http_connection_manager"

subFilter:

name: "envoy.filters.http.router"

patch:

operation: INSERT_BEFORE

value:

name: envoy.lua

typed_config:

"@type": "type.googleapis.com/envoy.extensions.filters.http.lua.v3.Lua"

inlineCode: |

function envoy_on_request(request_handle)

local path = request_handle:headers():get(":path")

request_handle:headers():replace(":path", string.lower(path))

end1.2.2.24. Red Hat OpenShift Service Mesh 2.0.3의 새 기능

이번 Red Hat OpenShift Service Mesh 릴리스는 CVE(Common Vulnerabilities and Exposures) 및 버그 수정을 제공합니다.

또한 이 릴리스에는 다음과 같은 새로운 기능이 있습니다.

-

지정된 Service Mesh Control Plane 네임스페이스에서 정보를 수집하는 옵션을

must-gather데이터 수집 툴에 추가했습니다. 자세한 내용은 OSSM-351을 참조하십시오. - 수백 개의 네임스페이스를 사용하여 Service Mesh Control Plane의 성능 향상

1.2.2.25. Red Hat OpenShift Service Mesh 2.0.2 새 기능

이번 Red Hat OpenShift Service Mesh 릴리스에는 IBM Z 및 IBM Power Systems에 대한 지원이 추가되었습니다. 또한 CVE(Common Vulnerabilities and Exposures) 및 버그 수정을 제공합니다.

1.2.2.26. Red Hat OpenShift Service Mesh 2.0.1 새 기능

이번 Red Hat OpenShift Service Mesh 릴리스는 CVE(Common Vulnerabilities and Exposures) 및 버그 수정을 제공합니다.

1.2.2.27. Red Hat OpenShift Service Mesh 2.0 새 기능

이번 Red Hat OpenShift Service Mesh 릴리스에는 Istio 1.6.5, Jaeger 1.20.0, Kiali 1.24.2, 3scale Istio Adapter 2.0 및 OpenShift Container Platform 4.6에 대한 지원이 추가되었습니다.

또한 이 릴리스에는 다음과 같은 새로운 기능이 있습니다.

- Service Mesh Control Plane의 설치, 업그레이드 및 관리를 간소화합니다.

- Service Mesh Control Plane의 리소스 사용량과 시작 시간을 줄입니다.

네트워크를 통한 상호 컨트롤 플레인 통신을 줄임으로써 성능을 향상시킵니다.

- Envoy의 SDS(Secret Discovery Service)에 대한 지원을 추가합니다. SDS는 Envoy 사이드 카 프록시에 시크릿을 전달하기 위한 보다 안전하고 효율적인 메커니즘입니다.

- 잘 알려진 보안 위험이 있는 Kubernetes Secrets를 사용할 필요가 없습니다.

새 인증서를 인식하기 위해 프록시를 다시 시작할 필요가 없으므로 인증서 순환 중에 성능이 향상됩니다.

- WebAssembly 확장을 사용하여 구축된 Istio의 Telemetry v2 아키텍처에 대한 지원이 추가되었습니다. 이 새로운 아키텍처는 상당한 성능 향상을 가져왔습니다.

- 서비스 메시 컨트롤 플레인을 보다 쉽게 관리할 수 있도록 간소화된 구성으로 ServiceMeshControlPlane 리소스를 v2로 업데이트합니다.

- WebAssembly 확장을 기술 프리뷰 기능으로 도입합니다.

1.2.3. 기술 프리뷰

이 릴리스의 일부 기능은 현재 기술 프리뷰 단계에 있습니다. 이러한 실험적 기능은 프로덕션용이 아닙니다.

기술 프리뷰 기능은 Red Hat 프로덕션 서비스 수준 계약(SLA)에서 지원되지 않으며 기능적으로 완전하지 않을 수 있습니다. 따라서 프로덕션 환경에서 사용하는 것은 권장하지 않습니다. 이러한 기능을 사용하면 향후 제품 기능을 조기에 이용할 수 있어 개발 과정에서 고객이 기능을 테스트하고 피드백을 제공할 수 있습니다. Red Hat 기술 프리뷰 기능의 지원 범위에 대한 자세한 내용은 기술 프리뷰 지원 범위를 참조하십시오.

1.2.3.1. Istio 호환성 및 지원 매트릭스

아래 표에서 기능은 다음과 같은 상태로 표시되어 있습니다.

- TP: 기술 프리뷰

- GA: 정식 출시일 (GA)

해당 기능은 Red Hat Customer Portal의 지원 범위를 참조하십시오.

표 1.3. Istio 호환성 및 지원 매트릭스

| 기능 | Istio 버전 | 지원 상태 | 설명 |

|---|---|---|---|

| holdApplicationUntilProxyStarts | 1.7 | TP | 프록시가 실행될 때까지 애플리케이션 컨테이너 시작을 차단합니다. |

| DNS 캡처 | 1.8 | GA | 기본적으로 사용하도록 설정 |

1.2.4. 사용되지 않거나 삭제된 기능

이전 릴리스에서 사용 가능하던 일부 기능이 더 이상 사용되지 않거나 삭제되었습니다.

더 이상 사용되지 않는 기능은 여전히 OpenShift Container Platform에 포함되어 있으며 계속 지원됩니다. 그러나 이 기능은 향후 릴리스에서 제거될 예정이므로 새로운 배포에는 사용하지 않는 것이 좋습니다.

제거된 기능은 제품에 더 이상 존재하지 않습니다.

1.2.4.1. Red Hat OpenShift Service Mesh 2.2의 더 이상 사용되지 않는 기능

ServiceMeshExtension API는 릴리스 2.2로 더 이상 사용되지 않으며 향후 릴리스에서 제거됩니다. ServiceMeshExtension API는 릴리스 2.2에서 계속 지원되지만 고객은 새 wasmPlugin API로 이동하기 시작해야 합니다.

1.2.4.2. Red Hat OpenShift Service Mesh 2.2 삭제된 기능

이번 릴리스에서는 모든 플랫폼의 Service Mesh 1.1을 기반으로 하는 Service Mesh Control Plane에 대한 지원 종료를 표시합니다.

1.2.4.3. Red Hat OpenShift Service Mesh 2.1 삭제된 기능

Service Mesh 2.1에서는 Mixer 구성 요소가 제거됩니다. 버그 수정 및 지원은 Service Mesh 2.0 라이프 사이클 종료를 통해 제공됩니다.

Mixer 플러그인이 활성화된 경우 Service Mesh 2.0.x 릴리스에서 2.1로 업그레이드할 수 없습니다. Mixer 플러그인은 WebAssembly 확장에 포팅해야 합니다.

1.2.4.4. Red Hat OpenShift Service Mesh 2.0의 중단된 기능

Mixer 구성 요소는 릴리스 2.0에서 더 이상 사용되지 않으며 릴리스 2.1에서 제거될 예정입니다. Mixer를 사용한 확장 구현은 릴리스 2.0에서 계속 지원되지만, 확장은 새로운 WebAssembly 메커니즘으로 마이그레이션되어야 합니다.

다음 리소스 유형은 Red Hat OpenShift Service Mesh 2.0에서 더 이상 지원되지 않습니다.

Policy(authentication.istio.io/v1alpha1)은 더 이상 지원되지 않습니다. 정책 리소스의 특정 구성에 따라 동일한 효과를 달성하기 위해 여러 리소스를 구성해야 할 수 있습니다.-

RequestAuthentication(security.istio.io/v1beta1) 사용 -

PeerAuthentication(security.istio.io/v1beta1) 사용

-

ServiceMeshPolicy(maistra.io/v1)는 더 이상 지원되지 않습니다.-

위에서 언급한 것처럼

RequestAuthentication또는PeerAuthentication을 사용하지만 Service Mesh Control Plane 네임스페이스에 배치합니다.

-

위에서 언급한 것처럼

RbacConfig(rbac.istio.io/v1alpha1)는 더 이상 지원되지 않습니다.-

RbacConfig,ServiceRole, 및ServiceRoleBinding을 포함하는AuthorizationPolicy(security.istio.io/v1beta1)로 대체됩니다.

-

ServiceMeshRbacConfig(maistra.io/v1)는 더 이상 지원되지 않습니다.-

위의 대로

AuthorizationPolicy를 사용하지만 Service Mesh Control Plane 네임스페이스에 배치합니다.

-

위의 대로

-

ServiceRole(rbac.istio.io/v1alpha1)은 더 이상 지원되지 않습니다. -

ServiceRoleBinding(rbac.istio.io/v1alpha1)은 더 이상 지원되지 않습니다. -

Kiali에서는

login및LDAP전략이 더 이상 사용되지 않습니다. 향후 버전에서는 OpenID 공급자를 사용한 인증을 도입할 예정입니다.

1.2.5. 확인된 문제

이러한 제한 사항은 Red Hat OpenShift Service Mesh에 있습니다.

- Red Hat OpenShift Service Mesh는 업스트림 Istio 프로젝트에서 완전히 지원되지 않기 때문에 IPv6를 지원하지 않습니다. 결과적으로 Red Hat OpenShift Service Mesh는 듀얼 스택 클러스터를 지원하지 않습니다.

- 그래프 레이아웃 - 애플리케이션 아키텍처 및 표시할 데이터(그래프 노드 및 상호 작용 수)에 따라 Kiali 그래프의 레이아웃이 다르게 렌더링됩니다. 모든 상황에 적합하게 렌더링되는 단일 레이아웃을 만드는 것이 불가능하지는 않지만 어렵기 때문에 Kiali는 다양한 레이아웃 옵션을 제공합니다. 다른 레이아웃을 선택하려면 그래프 설정 메뉴에서 다른 레이아웃 스키마를 선택할 수 있습니다.

- Kiali 콘솔에서 분산 추적 플랫폼 및 Grafana와 같은 관련 서비스에 처음 액세스하는 경우 인증서를 수락하고 OpenShift Container Platform 로그인 인증 정보를 사용하여 다시 인증해야 합니다. 이것은 프레임워크가 콘솔에 포함된 페이지를 표시하는 방법에 문제가 있기 때문입니다.

- Bookinfo 샘플 애플리케이션은 IBM Z 및 IBM Power에 설치할 수 없습니다.

- WebAssembly 확장은 IBM Z 및 IBM Power에서 지원되지 않습니다.

- LuaJIT는 IBM Power에서 지원되지 않습니다.

1.2.5.1. 서비스 메시의 알려진 문제

이는 Red Hat OpenShift Service Mesh에서 알려진 문제입니다.

- Istio-14743 이 Red Hat OpenShift Service Mesh 릴리스의 기반이 되는 Istio 버전의 제한으로 인해 현재 Service Mesh와 호환되지 않는 애플리케이션이 있을 수 있습니다. 자세한 내용은 링크 커뮤니티 관련 문제를 참조하십시오.

OSSM-1655 Kiali 대시보드에

SMCP에서 mTLS를 활성화한 후 오류가 표시됩니다.SMCP에서

spec.security.controlPlane.mtls설정을 활성화하면 Kiali 콘솔에 다음과 같은 오류 메시지가 표시됩니다.No subsets defined.OSSM-1505 이 문제는 OpenShift Container Platform 4.11에서

ServiceMeshExtension리소스를 사용하는 경우에만 발생합니다. OpenShift Container Platform 4.11에서ServiceMeshExtension를 사용하면 리소스가 준비되지 않습니다.oc describe ServiceMeshExtension를 사용하여 문제를 검사하면 다음 오류가 표시됩니다.stderr: pivot: function not implemented전에 마운트 네임스페이스를 생성하는 동안 오류가 발생했습니다.해결방법:

ServiceMeshExtension는 Service Mesh 2.2에서 더 이상 사용되지 않습니다.ServiceMeshExtension에서WasmPlugin리소스로 마이그레이션합니다. 자세한 내용은ServiceMeshExtension에서wasmPlugin 리소스로 마이그레이션을 참조하십시오.-

OSSM-1396 게이트웨이 리소스에

ServiceMeshControlPlane을 업데이트할 때 다시 생성하는 대신spec.externalIPs설정이 포함된 경우 게이트웨이가 제거되고 다시 생성되지 않습니다. - OSSM-1168 서비스 메시 리소스가 단일 YAML 파일로 생성되면 Envoy 프록시 사이드카가 Pod에 안정적으로 삽입되지 않습니다. SMCP, SMMR 및 Deployment 리소스가 개별적으로 생성되면 배포가 예상대로 작동합니다.

OSSM-1052 서비스 메시 컨트롤 플레인에서 ingressgateway에 대해 서비스

ExternalIP를 구성할 때 서비스가 생성되지 않습니다. SMCP의 스키마에 서비스 매개변수가 누락되어 있습니다.해결방법: SMCP 사양에서 게이트웨이 생성을 비활성화하고 서비스, 역할 및 RoleBinding을 포함하여 완전히 수동으로 게이트웨이 배포를 관리합니다.

OSSM-882 이는 서비스 메시 2.1 및 이전 버전에 적용됩니다. namespace는 accessible_namespace 목록에 있지만 Kiali UI에는 표시되지 않습니다. 기본적으로 Kiali는 이러한 네임스페이스는 일반적으로 메시의 일부가 아닌 내부 용도로만 사용되므로 "kube"로 시작하는 네임스페이스는 표시되지 않습니다.

예를 들어 'akube-a'라는 네임스페이스를 생성하여 Service Mesh 멤버 롤에 추가하면 Kiali UI에서 네임스페이스를 표시하지 않습니다. 정의된 제외 패턴의 경우 소프트웨어는 패턴으로 시작하거나 포함하는 네임스페이스를 제외합니다.

해결방법: Kiali 사용자 정의 리소스 설정을 변경하여 설정 앞에 캐스(^)를 지정합니다. 예를 들면 다음과 같습니다.

api: namespaces: exclude: - "^istio-operator" - "^kube-.*" - "^openshift.*" - "^ibm.*" - "^kiali-operator"-

MAISTRA-2692 Mixer가 제거된 경우 Service Mesh 2.0.x에 정의된 사용자 지정 지표를 2.1에서 사용할 수 없습니다. 사용자 지정 지표는

EnvoyFilter를 사용하여 구성할 수 있습니다. 명시적으로 문서화된 경우를 제외하고 Red Hat은EnvoyFilter구성을 지원할 수 없습니다. 이는 기본 Envoy API와 긴밀하게 결합되므로 이전 버전과의 호환성을 유지할 수 없습니다. -

MAISTRA-2648

ServiceMeshExtensions는 현재 IBM Z Systems에 배포된 메시와 호환되지 않습니다. MAISTRA-1959 2.0으로 마이그레이션 mTLS가 활성화된 경우 Prometheus 스크래핑(

spec.addons.prometheus.scrape를true로 설정)이 작동하지 않습니다. 또한 Kiali는 mTLS가 비활성화되면 관련 없는 그래프 데이터를 표시합니다.이 문제는 프록시 구성에서 포트 15020을 제외하여 해결할 수 있습니다. 예를 들면 다음과 같습니다.

spec: proxy: networking: trafficControl: inbound: excludedPorts: - 15020- MAISTRA-1314 Red Hat OpenShift Service Mesh는 IPv6를 지원하지 않습니다.

-

MAISTRA-453 새 프로젝트를 생성하고 즉시 pod를 배포하면 사이드카 삽입이 발생하지 않습니다. pod가 생성되기 전에 Operator에서

maistra.io/member-of를 추가하지 못하므로 사이드카 삽입을 수행하려면 pod를 삭제하고 다시 생성해야 합니다. - MAISTRA-158 동일한 호스트 이름을 참조하는 여러 게이트웨이를 적용하면 모든 게이트웨이가 작동을 중지합니다.

1.2.5.2. Kiali의 확인된 문제

Kiali의 새로운 문제는 OpenShift Service Mesh 프로젝트에서 생성되어야 하며 Component가 Kiali로 설정되어야 합니다.

다음은 Kiali에서 알려진 문제입니다.

- KIALI-2206 처음으로 Kiali 콘솔에 액세스했을 때 Kiali에 대해 캐시된 브라우저 데이터가 없는 경우 Kiali 서비스 상세 정보 페이지의 Metrics 탭에 있는 ‘Grafana에서 보기’ 링크가 잘못된 위치로 리디렉션됩니다. 이 문제가 발생하는 유일한 상황은 Kiali에 처음 액세스하는 경우입니다.

- KIALI-507 Kiali는 Internet Explorer 11을 지원하지 않습니다. 기본 프레임워크가 Internet Explorer를 지원하지 않기 때문입니다. Kiali 콘솔에 액세스하려면 Chrome, Edge, Firefox 또는 Safari 브라우저의 두 가지 최신 버전 중 하나를 사용하십시오.

1.2.5.3. Red Hat OpenShift distributed tracing 알려진 문제

이러한 제한 사항은 Red Hat OpenShift distributed tracing에 있습니다.

- Apache Spark가 지원되지 않습니다.

- AMQ/Kafka를 통한 스트리밍 배포는 IBM Z 및 IBM Power Systems에서는 지원되지 않습니다.

다음은 Red Hat OpenShift distributed tracing에 대해 알려진 문제입니다.

TRACING-2057 Kafka API가 Strimzi Kafka Operator 0.23.0을 지원하도록

v1beta2로 업데이트되었습니다. 그러나 이 API 버전은 AMQ Streams 1.6.3에서 지원되지 않습니다. 다음 환경의 경우 Jaeger 서비스가 업그레이드되지 않으며 새 Jaeger 서비스를 생성하거나 기존 Jaeger 서비스를 수정할 수 없습니다.- Jaeger Operator 채널: 1.17.x stable 또는 1.20.x stable

AMQ Streams Operator 채널: amq-streams-1.6.x

이 문제를 해결하려면 AMQ Streams Operator의 서브스크립션 채널을 amq-streams-1.7.x 또는 stable로 전환합니다.

1.2.6. 수정된 문제

현재 릴리스에서 다음 문제가 해결되었습니다.

1.2.6.1. 서비스 메시의 수정된 문제

OSSM-2053 Red Hat OpenShift Service Mesh Operator 2.2 또는 2.3을 사용하는 경우 SMMR 컨트롤러가

SMMR.status.configuredMembers에서 멤버 네임스페이스를 제거했습니다. 이로 인해 몇 분 동안 멤버 네임스페이스의 서비스를 사용할 수 없게 되었습니다.Red Hat OpenShift Service Mesh Operator 2.2 또는 2.3을 사용하면 SMMR 컨트롤러에서 더 이상

SMMR.status.configuredMembers의 네임스페이스를 제거하지 않습니다. 대신 컨트롤러는SMMR.status.pendingMembers에 네임스페이스를 추가하여 해당 네임스페이스가 최신 상태가 되지 않음을 나타냅니다. 조정 중에 각 네임스페이스가 SMCP와 동기화되므로 네임스페이스는SMMR.status.pendingMembers에서 자동으로 제거됩니다.-

OSSM-1668 새 필드

spec.security.jwksResolverCA가 버전 2.1SMCP에 추가되었지만 2.2.0 및 2.2.1 릴리스에서는 누락되었습니다. 이 필드가 누락된 Operator 버전에 문제가 있는 Operator 버전에서 업그레이드할 때SMCP에서.spec.security.jwksResolverCA필드를 사용할 수 없었습니다. -

OSSM-1325 istiod Pod가 충돌하고 다음 오류 메시지:

치명적 오류: 동시 맵 반복 및 쓰기매핑을 표시합니다. OSSM-1211 장애 조치를 위해 Federated 서비스 메시를 구성하면 예상대로 작동하지 않습니다.

Istiod pilot 로그에는

envoy connection [C289] TLS 오류가 표시됩니다. 337047686:SSL 루틴:tls_process_server_certificate:certificate 검증 실패-

OSSM-1099 Kiali 콘솔에

Sorry라는 메시지가 표시되었습니다. 새로 고침을 시도하거나 다른 페이지로 이동합니다. - SMCP에 정의된 OSSM-1074 Pod 주석은 Pod에 삽입되지 않습니다.

- OSSM-999 Kiali retention가 예상대로 작동하지 않았습니다. 대시보드 그래프에서 일정 시간이 회색이었습니다.

-

OSSM-797 Kiali Operator Pod는 Operator를 설치하거나 업데이트하는 동안

CreateContainerConfigError를 생성합니다. -

kube로 시작하는 OSSM-722 네임스페이스는 Kiali에서 숨겨집니다. -

OSSM-569 Prometheus

istio-proxy컨테이너에 CPU 메모리 제한이 없습니다. Prometheusistio-proxy사이드카에서spec.proxy.runtime.container에 정의된 리소스 제한을 사용합니다. - OSSM-449 VirtualService 및 Service로 인해 "도메인에 대한 고유한 값만 허용됩니다. 도메인 중복 항목이 허용됩니다."

- OSSM-419 이름이 유사한 네임스페이스는 서비스 메시 멤버 역할에 네임스페이스를 정의할 수 없는 경우에도 Kiali 네임스페이스 목록에 모두 표시됩니다.

- OSSM-296 Kiali 사용자 지정 리소스(CR)에 상태 구성을 추가할 때 Kiali configmap에 복제되지 않습니다.

- OSSM-291 Kiali 콘솔의 애플리케이션, 서비스 및 워크로드 페이지에서 ‘필터에서 레이블 삭제’ 기능이 작동하지 않습니다.

- OSSM-289 Kiali 콘솔에는 ‘istio-ingressgateway’ 및 ‘jaeger-query’ 서비스에 대한 서비스 세부 정보 페이지에 표시되는 추적이 없습니다. 추적은 Jaeger에 있습니다.

- OSSM-287 Kiali 콘솔에는 그래프 서비스에 표시되는 추적이 없습니다.

OSSM-285 Kiali 콘솔에 액세스하려고 할 때 “Error trying to get OAuth Metadata”와 같은 오류 메시지가 표시됩니다.

해결방법: Kiali 포드를 다시 시작합니다.

MAISTRA-2735 Red Hat OpenShift Service Mesh 버전 2.1에서 SMCP를 조정할 때 Service Mesh Operator가 삭제하는 리소스입니다. 이전에는 Operator에서 다음 레이블이 있는 리소스를 삭제했습니다.

-

maistra.io/owner -

app.kubernetes.io/version

이제 Operator에서

app.kubernetes.io/managed-by=maistra-istio-operator레이블도 포함하지 않는 리소스를 무시합니다. 자체 리소스를 생성하는 경우app.kubernetes.io/managed-by=maistra-istio-operator레이블을 추가하지 않아야 합니다.-

-

MAISTRA-2687 Red Hat OpenShift Service Mesh 2.1 페더레이션 게이트웨이는 외부 인증서를 사용할 때 전체 인증서 체인을 전송하지 않습니다. 서비스 메시 페더레이션 송신 게이트웨이는 클라이언트 인증서만 전송합니다. 페더레이션 수신 게이트웨이는 루트 인증서만 알고 있으므로 페더레이션 가져오기

ConfigMap에 루트 인증서를 추가하지 않는 한 클라이언트 인증서를 확인할 수 없습니다. -

MAISTRA-2635 더 이상 사용되지 않는 Kubernetes API 교체. OpenShift Container Platform 4.8과 호환되도록

apiextensions.k8s.io/v1beta1API는 Red Hat OpenShift Service Mesh 2.0.8에서 더 이상 사용되지 않습니다. -

MAISTRA-2631 WASM 기능은 nsenter 바이너리가 존재하지 않기 때문에 podman이 실패하기 때문에 작동하지 않습니다. Red Hat OpenShift Service Mesh는 다음과 같은 오류 메시지를 생성합니다.

오류: CNI 네트워크 플러그인 구성 오류 exec: "nsenter": $PATH에서 실행 가능 파일을 찾을 수 없습니다. 이제 컨테이너 이미지에 nsenter가 포함되고 WASM이 예상대로 작동합니다. - MAISTRA-2534 istiod에서 JWT 규칙에 지정된 발급자에 대한 JWKS를 가져오기를 시도하면 발급자 서비스가 502로 응답했습니다. 이로 인해 프록시 컨테이너가 준비되지 않아 배포가 중단되었습니다. 커뮤니티 버그 수정이 Service Mesh 2.0.7 릴리스에 포함되어 있습니다.

MAISTRA-2411 Operator가

ServiceMeshControlPlane에서spec.gateways.additionaIngress를 사용하여 새 수신 게이트웨이를 생성하면 Operator는 기본 istio-ingressgateway에 대한 추가 수신 게이트웨이에 대한NetworkPolicy를 생성하지 않습니다. 이로 인해 새 게이트웨이 경로에서 503 응답이 발생합니다.해결방법: <istio-system> 네임스페이스에서

NetworkPolicy를 수동으로 생성합니다.MAISTRA-2401 CVE-2021-3586 servicemesh-operator: NetworkPolicy 리소스가 인그레스 리소스에 대해 포트가 잘못 지정되었습니다. Red Hat OpenShift Service Mesh에 설치된 NetworkPolicy 리소스가 액세스할 수 있는 포트를 올바르게 지정하지 않았습니다. 이로 인해 모든 pod에서 이러한 리소스의 모든 포트에 액세스할 수 있었습니다. 다음 리소스에 적용되는 네트워크 정책은 영향을 받습니다.

- Galley

- Grafana

- Istiod

- Jaeger

- Kiali

- Prometheus

- Sidecar injector

-

MAISTRA-2378 클러스터가

ovs-multitenant와 함께 OpenShift SDN을 사용하도록 구성되고 메시에 다수의 네임스페이스(200+)가 포함된 경우 OpenShift Container Platform 네트워킹 플러그인은 네임스페이스를 빠르게 구성할 수 없습니다. 서비스 메시의 시간이 초과되어 서비스 메시에서 네임스페이스가 지속적으로 드롭된 다음 다시 나열됩니다. - MAISTRA-2370 listerInformer에서 tombstones를 처리합니다. 업데이트된 캐시 코드베이스는 네임스페이스 캐시에서 집계된 캐시로 이벤트를 변환할 때 tombstones를 처리하지 않아 go 루틴에서 패닉이 발생했습니다.

MAISTRA-2117 operator에 선택적

ConfigMap마운트 추가. 이제 CSV에 선택적ConfigMap볼륨 마운트가 포함되어 있으며, 이 마운트는smcp-templatesConfigMap이 존재하는 경우 마운트됩니다.smcp-templatesConfigMap이 없으면 마운트된 디렉터리가 비어 있습니다.ConfigMap을 생성할 때 디렉터리는ConfigMap의 항목으로 채워지며SMCP.spec.profiles에서 참조할 수 있습니다. Service Mesh Operator를 다시 시작할 필요가 없습니다.smcp-templates ConfigMap을 마운트하기 위해 수정된 CSV가 있는 2.0 Operator를 사용하는 고객은 Red Hat OpenShift Service Mesh 2.1로 업그레이드할 수 있습니다. 업그레이드 후 CSV를 편집하지 않고 기존 ConfigMap과 포함된 프로필을 계속 사용할 수 있습니다. 이전에 다른 이름으로 ConfigMap을 사용한 고객은 업그레이드 후 ConfigMap의 이름을 변경하거나 CSV를 업데이트해야 합니다.

-

MAISTRA-2010 AuthorizationPolicy는

request.regex.headers필드를 지원하지 않습니다.validatingwebhook는 필드가 있는 모든 AuthorizationPolicy를 거부하며, 이를 비활성화한 경우에도 Pilot은 동일한 코드를 사용하여 유효성을 검사하려고 시도하지만 작동하지 않습니다. MAISTRA-1979 2.0으로 마이그레이션 변환 Webhook는

SMCP.status를 v2에서 v1로 변환할 때 다음과 같은 중요한 필드를 삭제합니다.- conditions

- components

- observedGeneration

annotations

Operator를 2.0으로 업그레이드하면 리소스의 maistra.io/v1 버전을 사용하여 SMCP 상태를 판독하는 클라이언트 툴이 중단될 수 있습니다.

또한

oc get servicemeshcontrolplanes.v1.maistra.io를 실행할 때 READY 및 STATUS 열이 비어 있습니다.

ServiceMeshExtensions에 대한 MAISTRA-1947 기술 프리뷰 업데이트는 적용되지 않습니다.

해결방법:

ServiceMeshExtensions를 제거하고 다시 생성합니다.-

MAISTRA-1983 2.0으로 마이그레이션 기존의 유효하지 않은

ServiceMeshControlPlane을 사용하여 2.0.0으로 업그레이드하면 쉽게 복구할 수 없습니다.ServiceMeshControlPlane리소스의 유효하지 않은 항목으로 인해 복구할 수 없는 오류가 발생했습니다. 수정으로 오류를 복구할 수 있습니다. 유효하지 않은 리소스를 삭제하고 새 리소스로 교체하거나 리소스를 편집하여 오류를 수정할 수 있습니다. 리소스 편집에 대한 자세한 내용은 [Red Hat OpenShift Service Mesh 설치 구성]을 참조하십시오. - MAISTRA-1502 버전 1.0.10에서 CVE가 수정되므로 Grafana의 홈 대시보드 메뉴에서는 Istio 대시보드 를 사용할 수 없습니다. Istio 대시보드에 액세스하려면 탐색 패널에서 대시보드 메뉴를 클릭하고 관리 탭을 선택합니다.

- MAISTRA-1399 Red Hat OpenShift Service Mesh를 사용하면 더 이상 지원되지 않는 CNI 프로토콜을 설치할 수 없습니다. 지원되는 네트워크 구성은 변경되지 않았습니다.

- MAISTRA-1089 2.0으로 마이그레이션 비 컨트롤 플레인 네임스페이스에서 생성된 게이트웨이는 자동으로 삭제됩니다. SMCP 사양에서 게이트웨이 정의를 제거한 후 이러한 리소스를 수동으로 삭제해야 합니다.

MAISTRA-858 Istio 1.1.x와 관련된 더 이상 사용하지 않는 옵션 및 구성을 설명하는 다음과 같은 Envoy 로그 메시지가 예상됩니다.

- [2019-06-03 07:03:28.943][19][warning][misc] [external/envoy/source/common/protobuf/utility.cc:129] Using deprecated option 'envoy.api.v2.listener.Filter.config'. 이 구성은 곧 Envoy에서 삭제될 예정입니다.

- [2019-08-12 22:12:59.001][13][warning][misc] [external/envoy/source/common/protobuf/utility.cc:174] Using deprecated option 'envoy.api.v2.Listener.use_original_dst' from file lds.proto. 이 구성은 곧 Envoy에서 삭제될 예정입니다.

MAISTRA-806 제거된 Istio Operator pod로 인해 메시 및 CNI가 배포되지 않습니다.

해결방법: 제어 창을 배포하는 동안

istio-operatorpod가 제거되면, 제거된istio-operatorpod를 삭제합니다.- MAISTRA-681 서비스 메시 컨트롤 플레인에 네임스페이스가 많은 경우 성능 문제가 발생할 수 있습니다.

- MAISTRA-193 citadel에 대해 상태 확인이 활성화되면 예기치 않은 콘솔 정보 메시지가 표시됩니다.

- Bugzilla 1821432 OpenShift Container Platform 사용자 정의 리소스 세부 정보 페이지의 토글 제어가 CR을 올바르게 업데이트하지 않습니다. OpenShift Container Platform 웹 콘솔의 SMCP(Service Mesh Control Plane) 개요 페이지의 UI 토글 제어가 리소스에서 잘못된 필드를 업데이트하는 경우가 있습니다. SMCP를 업데이트하려면 토글 제어를 클릭하는 대신 YAML 콘텐츠를 직접 편집하거나 명령줄에서 리소스를 업데이트합니다.

1.2.6.2. Red Hat OpenShift distributed tracing 고정 문제

TRACING-2337 Jaeger는 다음과 유사한 Jaeger 로그에 반복적인 경고 메시지를 기록합니다.

{"level":"warn","ts":1642438880.918793,"caller":"channelz/logging.go:62","msg":"[core]grpc: Server.Serve failed to create ServerTransport: connection error: desc = \"transport: http2Server.HandleStreams received bogus greeting from client: \\\"\\\\x16\\\\x03\\\\x01\\\\x02\\\\x00\\\\x01\\\\x00\\\\x01\\\\xfc\\\\x03\\\\x03vw\\\\x1a\\\\xc9T\\\\xe7\\\\xdaCj\\\\xb7\\\\x8dK\\\\xa6\\\"\"","system":"grpc","grpc_log":true}이 문제는 gRPC 포트가 아닌 쿼리 서비스의 HTTP(S) 포트만 노출하여 해결되었습니다.

- TRACING-2009 Jaeger Operator가 Strimzi Kafka Operator 0.23.0에 대한 지원을 포함하도록 업데이트되었습니다.

-

TRACING-1907 애플리케이션 네임스페이스에서 구성 맵이 누락되어 Jaeger 에이전트 사이드카 삽입이 실패했습니다. 잘못된

OwnerReference필드 설정으로 인해 구성 맵이 자동으로 삭제되었으며 결과적으로 애플리케이션 Pod가 "ContainerCreating" 단계를 통과하지 않았습니다. 잘못된 설정이 제거되었습니다. - TRACING-1725 TRACING-1631에 대한 후속 조치입니다. 동일한 이름을 사용하지만 다른 네임스페이스 내에 Jaeger 프로덕션 인스턴스가 여러 개인 경우 Elasticsearch 인증서가 올바르게 조정되는지 확인하기 위한 추가 수정 사항입니다. BZ-1918920도 참조하십시오.

- TRACING-1631 동일한 이름을 사용하지만 다른 네임스페이스 내의 여러 Jaeger 프로덕션 인스턴스로, Elasticsearch 인증서 문제를 발생시킵니다. 여러 서비스 메시가 설치되면 모든 Jaeger Elasticsearch 인스턴스에 개별 시크릿 대신 동일한 Elasticsearch 시크릿이 있어 OpenShift Elasticsearch Operator가 모든 Elasticsearch 클러스터와 통신할 수 없습니다.

- TRACING-1300 Istio 사이드카를 사용할 때 에이전트와 수집기 간의 연결에 실패했습니다. Jaeger Operator 업데이트는 Jaeger 사이드카 에이전트와 Jaeger 수집기 간의 TLS 통신을 기본적으로 활성화했습니다.

-

TRACING-1208 Jaeger UI에 액세스할 때 인증 “500 Internal Error”입니다. OAuth를 사용하여 UI를 인증할 때 oauth-proxy 사이드카가

additionalTrustBundle로 설치할 때 정의된 사용자 정의 CA 번들을 신뢰하지 않기 때문에 500 오류가 발생합니다. -

TRACING-1166 현재 연결이 끊긴 환경에서 Jaeger 스트리밍 전략을 사용할 수 없습니다. Kafka 클러스터가 프로비저닝되면 오류가 발생합니다.

이미지 registry.redhat.io/amq7/amq-streams-kafka-24-rhel7@sha256:f9ceca004f1b7dccb3b82d9a8027961f9fe4104e0ed69752c0bdd8078b4a1076를 가져오지 못했습니다. - TRACING-809 Jaeger Ingester는 Kafka 2.3과 호환되지 않습니다. Jaeger Ingester의 두 개 이상의 인스턴스와 트래픽이 충분한 경우 로그에 지속적으로 리밸런싱 메시지를 생성합니다. 이는 Kafka 2.3.1에서 수정된 Kafka 2.3의 문제의 재발로 인해 발생합니다. 자세한 내용은 Jaegertracing-1819를 참조하십시오.

BZ-1918920/LOG-1619 업데이트 후 Elasticsearch Pod가 자동으로 다시 시작되지 않습니다.

해결방법: Pod를 수동으로 다시 시작합니다.

1.3. 서비스 메시 이해

Red Hat OpenShift Service Mesh는 서비스 메시에서 네트워크로 연결된 마이크로 서비스에 대해 동작 정보 및 운영 제어용 플랫폼을 제공합니다. Red Hat OpenShift Service Mesh를 사용하면 OpenShift Container Platform 환경에서 마이크로 서비스를 연결, 보호 및 모니터링할 수 있습니다.

1.3.1. 서비스 메시 이해

서비스 메시는 분산 마이크로 서비스 아키텍처에서 애플리케이션을 구성하는 마이크로 서비스 네트워크와 이러한 마이크로 서비스 간의 상호 작용입니다. 서비스 메시의 크기와 복잡성이 증가함에 따라 이를 이해하고 관리하는 것이 어려워질 수 있습니다.

오픈 소스 Istio 프로젝트를 기반으로 하는 Red Hat OpenShift Service Mesh는 서비스 코드를 변경할 필요 없이 기존 분산 애플리케이션에 투명 계층을 추가합니다. 마이크로 서비스 간의 모든 네트워크 통신을 차단하는 메시의 관련 서비스에 특수 사이드카 프록시를 배포하여 Red Hat OpenShift Service Mesh 지원을 서비스에 추가합니다. 서비스 메시 컨트롤 플레인 기능을 사용하여 서비스 메시를 구성하고 관리합니다.

Red Hat OpenShift Service Mesh를 사용하면, 다음과 같은 기능을 제공하는 배포된 서비스 네트워크를 쉽게 생성할 수 있습니다.

- 검색

- 로드 밸런싱

- 서비스 간 인증

- 장애 복구

- 지표

- 모니터링

Red Hat OpenShift Service Mesh는 다음과 같은 보다 복잡한 운영 기능을 제공합니다:

- A/B 테스트

- Canary 릴리스

- 액세스 제어

- 엔드 투 엔드 인증

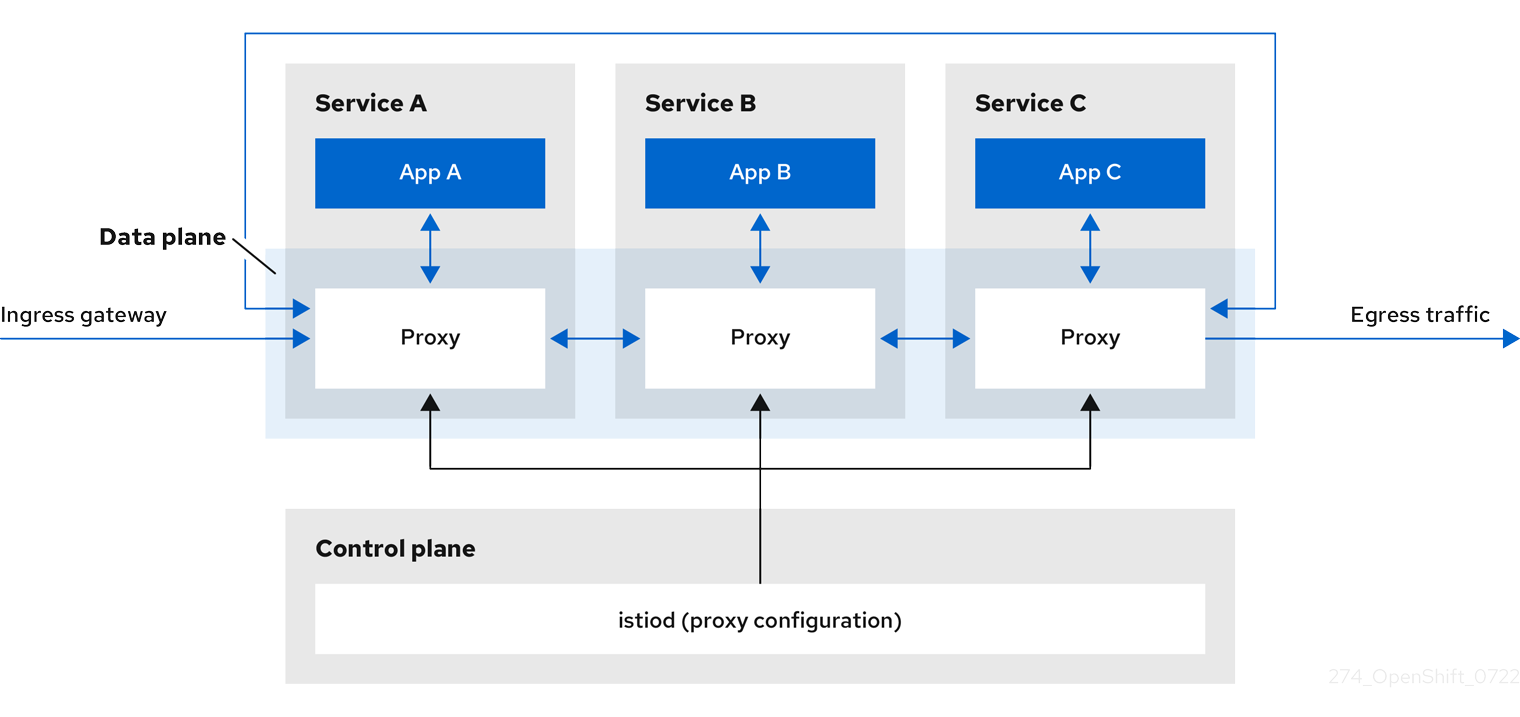

1.3.2. 서비스 메시 아키텍처

서비스 메시 기술은 네트워크 통신 수준에서 작동합니다. 즉, 서비스 메시 구성 요소는 요청을 수정하거나, 리디렉션하거나, 다른 서비스에 새 요청을 생성하여 마이크로 서비스로 들어오고 나가는 트래픽을 캡처하거나 가로챕니다.

Red Hat OpenShift Service Mesh는 높은 수준에서 데이터 플레인과 컨트롤 플레인으로 구성됩니다.

데이터 플레인은 pod에서 애플리케이션 컨테이너와 함께 실행되며 서비스 메시의 마이크로 서비스 간 인바운드 및 아웃바운드 네트워크 통신을 가로채고 제어하는 지능형 프록시 집합입니다. 데이터 플레인은 인바운드(ingress) 및 아웃바운드(egress) 네트워크 트래픽을 가로채는 방식으로 구현됩니다. Istio 데이터 플레인은 pod의 사이드 애플리케이션 컨테이너와 함께 실행되는 Envoy 컨테이너로 구성됩니다. Envoy 컨테이너는 pod 내외의 모든 네트워크 통신을 제어하는 프록시 역할을 합니다.

Envoy 프록시는 데이터 플레인 트래픽과 상호 작용하는 유일한 Istio 구성 요소입니다. 서비스 간에 들어오는 모든(ingress) 및 발신(egress) 네트워크 트래픽은 프록시를 통해 이동합니다. 또한 Envoy 프록시는 메시 내에서 서비스 트래픽과 관련된 모든 메트릭을 수집합니다. Envoy 프록시는 서비스와 동일한 Pod에서 실행되는 사이드카로 배포됩니다. Envoy 프록시는 메시 게이트웨이를 구현하는 데도 사용됩니다.

- 사이드카 프록시는 연결된 워크로드 인스턴스에 대한 인바운드 및 아웃바운드 통신을 관리합니다.

게이트웨이는 들어오거나 나가는 HTTP/TCP 연결을 수신하는 로드 밸런서 장치로 작동하는 프록시입니다. 게이트웨이 구성은 서비스 워크로드와 함께 실행되는 사이드카 Envoy 프록시가 아닌, 메시의 에지에서 실행되는 독립 실행형 Envoy 프록시에 적용됩니다. 게이트웨이를 사용하여 메시에 대한 인바운드 및 아웃바운드 트래픽을 관리하여 메시에 들어오거나 나가려는 트래픽을 지정할 수 있습니다.

- Ingress-gateway - 수신 컨트롤러라고도 하는 Ingress 게이트웨이는 서비스 메시를 입력하는 트래픽을 수신하고 제어하는 전용 Envoy 프록시입니다. Ingress 게이트웨이를 사용하면 모니터링 및 경로 규칙과 같은 기능을 클러스터로 들어오는 트래픽에 적용할 수 있습니다.

- egress-gateway - 송신 컨트롤러라고도 하는 Egress 게이트웨이는 서비스 메시를 나가는 트래픽을 관리하는 전용 Envoy 프록시입니다. Egress Gateway를 사용하면 모니터링 및 경로 규칙과 같은 기능이 메시를 종료하는 트래픽에 적용할 수 있습니다.

컨트롤 플레인은 데이터 플레인을 구성하는 프록시를 관리하고 구성합니다. 구성에 대한 권한 있는 소스이며 액세스 제어 및 사용 정책을 관리하고 서비스 메시의 프록시에서 메트릭을 수집합니다.

Istio 컨트롤 플레인은 이전의 여러 컨트롤 플레인 구성 요소(Citadel, Galley, Pilot)를 단일 바이너리로 통합하는 Istiod로 구성됩니다. Istiod는 서비스 검색, 구성 및 인증서 관리를 제공합니다. 고급 라우팅 규칙을 Envoy 구성으로 변환하고 런타임 시 사이드카로 전달합니다.

- Istiod는 CA(인증 기관) 역할을 하며 데이터 플레인에서 보안 mTLS 통신을 지원하는 인증서를 생성할 수 있습니다. 이를 위해 외부 CA를 사용할 수도 있습니다.

- Istiod는 OpenShift 클러스터에 배포된 워크로드에 사이드카 프록시 컨테이너를 삽입하는 역할을 합니다.

Red Hat OpenShift Service Mesh는 istio-operator를 사용하여 컨트롤 플레인 설치를 관리합니다. Operator는 OpenShift 클러스터에서 공통 활동을 구현하고 자동화할 수 있는 소프트웨어입니다. 컨트롤러 역할을 하여 클러스터에서 원하는 오브젝트 상태(이 경우 Red Hat OpenShift Service Mesh 설치)를 설정하거나 변경할 수 있습니다.

또한 Red Hat OpenShift Service Mesh는 다음 Istio 추가 기능도 제품의 일부로 번들로 제공합니다.

- Kiali - Kiali는 Red Hat OpenShift Service Mesh의 관리 콘솔입니다. 대시보드, 관찰 기능, 강력한 구성 및 유효성 검사 기능을 제공합니다. 트래픽 토폴로지를 유추하고 서비스 메시의 구조를 표시하고 메시의 상태를 표시합니다. Kiali는 자세한 지표, 강력한 검증, Grafana 액세스 및 분산 추적 플랫폼과의 강력한 통합을 제공합니다.

- Prometheus - Red Hat OpenShift Service Mesh는 Prometheus를 사용하여 서비스의 원격 분석 정보를 저장합니다. Kiali는 Prometheus를 사용하여 메트릭, 상태 및 메시 토폴로지를 가져옵니다.

- Jaeger - Red Hat OpenShift Service Mesh는 분산 추적 플랫폼을 지원합니다. Jaeger는 여러 서비스 간에 단일 요청과 관련된 추적을 중앙 집중화하고 표시하는 오픈소스 추적 기능 서버입니다. 분산 추적 플랫폼을 사용하여 마이크로서비스 기반 분산 시스템을 모니터링하고 문제를 해결할 수 있습니다.

- Elasticsearch - Elasticsearch는 오픈 소스 분산 JSON 기반 검색 및 분석 엔진입니다. 분산 추적 플랫폼은 영구 스토리지에 Elasticsearch를 사용합니다.

- Grafana - Grafana는 메시 관리자에게 Istio 데이터에 대한 고급 쿼리 및 메트릭 분석 및 대시보드를 제공합니다. 선택적으로 Grafana를 사용하여 서비스 메시 메트릭을 분석할 수 있습니다.

Red Hat OpenShift Service Mesh에서 다음 Istio 통합이 지원됩니다.

- 3scale - Istio는 Red Hat 3scale API Management 솔루션과의 선택적 통합을 제공합니다. 2.1 이전의 버전의 경우 이 통합은 3scale Istio 어댑터를 통해 수행되었습니다. 버전 2.1 이상의 경우 3scale 통합은 WebAssembly 모듈을 통해 수행됩니다.

3scale 어댑터 설치 방법에 대한 자세한 내용은 3scale Istio 어댑터 설명서를 참조하십시오.

1.3.3. Kiali 이해

Kiali는 서비스 메시의 마이크로 서비스와 해당 연결 방법을 표시하여 서비스 메시를 시각화할 수 있습니다.

1.3.3.1. Kiali 개요

Kiali는 OpenShift Container Platform에서 실행 중인 서비스 메시에 대한 관찰 기능을 제공합니다. Kiali는 Istio 서비스 메시를 정의하고 검증하며 관찰하는 데 도움이 됩니다. 이를 통해 토폴로지를 유추하여 서비스 메시의 구조를 이해하고 서비스 메시의 상태에 대한 정보를 제공할 수 있습니다.

Kiali는 회로 차단기, 요청 속도, 대기 시간, 트래픽 흐름 그래프와 같은 기능에 대한 가시성을 제공하는 네임스페이스의 대화형 그래프 보기를 실시간으로 제공합니다. Kiali는 애플리케이션에서 서비스 및 워크로드에 이르기까지 다양한 수준의 구성 요소에 대한 통찰력을 제공하며, 선택한 그래프 노드 또는 에지에서 상황별 정보에 대한 상호 작용과 차트를 표시할 수 있습니다. Kiali는 게이트웨이, 대상 규칙, 가상 서비스, 메시 정책 등과 같은 Istio 구성의 유효성을 확인하는 기능도 제공합니다. Kiali는 자세한 지표를 제공하며 고급 쿼리에 기본 Grafana 통합이 가능합니다. Jaeger를 Kiali 콘솔에 통합하면 분산 추적이 제공됩니다.

Kiali는 기본적으로 Red Hat OpenShift Service Mesh의 일부로 설치됩니다.

1.3.3.2. Kiali 아키텍처

Kiali는 오픈 소스 Kiali 프로젝트를 기반으로 합니다. Kiali는 Kiali 애플리케이션과 Kiali 콘솔이라는 두 가지 구성 요소로 구성됩니다.

- Kiali 애플리케이션(백엔드) - 이 구성 요소는 컨테이너 애플리케이션 플랫폼에서 실행되고 서비스 메시 구성 요소와 통신하며, 데이터를 검색 및 처리하고, 이 데이터를 콘솔에 노출합니다. Kiali 애플리케이션에는 스토리지가 필요하지 않습니다. 클러스터에 애플리케이션을 배포할 때 구성은 ConfigMaps 및 시크릿에 설정됩니다.

- Kiali 콘솔(프론트엔드) - Kiali 콘솔은 웹 애플리케이션입니다. Kiali 애플리케이션은 Kiali 콘솔을 제공하며 이를 사용자에게 표시하기 위해 데이터의 백엔드를 쿼리합니다.

또한 Kiali는 컨테이너 애플리케이션 플랫폼과 Istio에서 제공하는 외부 서비스 및 구성 요소에 따라 달라집니다.

- Red Hat Service Mesh(Istio) - Istio는 Kiali 요구 사항입니다. Istio는 서비스 메시를 제공하고 제어하는 구성 요소입니다. Kiali와 Istio를 별도로 설치할 수 있지만 Kiali는 Istio에 따라 달라지며 Istio가 존재하지 않는 경우 작동하지 않습니다. Kiali는 Prometheus 및 클러스터 API를 통해 노출되는 Istio 데이터와 구성을 검색해야 합니다.

- Prometheus - 전용 Prometheus 인스턴스는 Red Hat OpenShift Service Mesh 설치의 일부로 포함되어 있습니다. Istio Telemetry가 활성화되면 지표 데이터가 Prometheus에 저장됩니다. Kiali는 이 Prometheus 데이터를 사용하여 메시 토폴로지 확인, 지표 표시, 상태 계산, 가능한 문제 표시 등의 작업을 수행합니다. Kiali는 Prometheus와 직접 통신하고 Istio Telemetry에서 사용하는 데이터 스키마를 가정합니다. Prometheus는 Istio 종속성 및 Kiali에 대한 하드 종속성이며, 대부분의 Kiali 기능은 Prometheus없이 작동하지 않습니다.

- 클러스터 API - Kiali는 서비스 메시 구성을 가져와 해결하기 위해 OpenShift Container Platform(클러스터 API)의 API를 사용합니다. Kiali는 클러스터 API를 쿼리하여 네임스페이스, 서비스, 배포, pod 및 기타 엔터티에 대한 정의를 검색합니다. 또한 Kiali는 다른 클러스터 엔티티 간의 관계를 해결하기 위해 쿼리를 만듭니다. 클러스터 API는 가상 서비스, 대상 규칙, 경로 규칙, 게이트웨이, 할당량 등과 같은 Istio 구성을 검색하도록 쿼리합니다.

- Jaeger - Jaeger는 선택 사항이지만 Red Hat OpenShift Service Mesh의 일부로 설치됩니다. 기본 Red Hat OpenShift Service Mesh 설치의 일부로 분산 추적 플랫폼을 설치하면 Kiali 콘솔에 분산 추적 데이터를 표시하는 탭이 포함됩니다. Istio의 분산 추적 기능을 비활성화하면 추적 데이터를 사용할 수 없습니다. 또한 사용자가 추적 데이터를 보기 위해 Service Mesh Control Plane이 설치된 네임스페이스에 대한 액세스 권한이 있어야 합니다.

- Grafana - Grafana는 선택 사항이지만 Red Hat OpenShift Service Mesh의 일부로 설치됩니다. 사용 가능한 경우, Kiali의 지표 페이지에 사용자를 Grafana의 동일한 지표로 안내하는 링크가 표시됩니다. 사용자가 Grafana 대시보드에 대한 링크를 보고 Grafana 데이터를 보려면 Service Mesh Control Plane이 설치된 네임스페이스에 대한 액세스 권한이 있어야 합니다.

1.3.3.3. Kiali 기능

Kiali 콘솔은 Red Hat Service Mesh와 통합되어 다음 기능을 제공합니다.

- 상태 - 애플리케이션, 서비스 또는 워크로드에 대한 문제를 빠르게 식별합니다.

- 토폴로지 - 애플리케이션, 서비스 또는 워크로드가 Kiali 그래프를 통해 통신하는 방식을 시각화합니다.

- 지표 - 사전 정의된 지표 대시 보드를 통해 Go, Node.js. Quarkus, Spring Boot, Thorntail, Vert.x에 대한 서비스 메시 및 애플리케이션 성능을 차트로 작성할 수 있습니다. 또한 사용자 정의 대시보드를 생성할 수도 있습니다.

- 추적 - Jaeger와의 통합을 통해 애플리케이션을 구성하는 다양한 마이크로 서비스를 통해 요청 경로를 따를 수 있습니다.

- 검증 - 가장 일반적인 Istio 오브젝트에 대한 고급 검증(대상 규칙, 서비스 항목, 가상 서비스 등)을 수행합니다.

- 구성 - 마법사를 사용하거나 Kiali 콘솔의 YAML 편집기에서 직접 Istio 라우팅 구성을 생성, 업데이트 및 삭제할 수 있는 옵션입니다.

1.3.4. 분산 추적 이해

사용자가 애플리케이션에서 작업을 수행할 때마다 응답을 생성하기 위해 참여하도록 다양한 서비스를 필요로 할 수 있는 아키텍처에 의해 요청이 실행됩니다. 이 요청의 경로는 분산 트랜잭션입니다. 분산 추적 플랫폼을 사용하면 애플리케이션을 구성하는 다양한 마이크로 서비스를 통해 요청의 경로를 따르는 분산 추적을 수행할 수 있습니다.

분산 추적은 분산 트랜잭션에 있는 전체 이벤트 체인을 이해하기 위해 일반적으로 다양한 프로세스 또는 호스트에서 실행되는 다양한 작업 단위에 대한 정보를 결합하는 데 사용되는 기술입니다. 분산 추적을 통해 개발자는 대규모 서비스 지향 아키텍처에서 호출 흐름을 시각화할 수 있습니다. 직렬화, 병렬 처리 및 대기 시간 소스를 이해하는 데 유용할 수 있습니다.

분산 추적 플랫폼은 마이크로 서비스의 전체 스택에서 개별 요청 실행을 기록하고 이를 추적으로 제공합니다. 추적은 시스템을 통한 데이터/실행 경로입니다. 엔드 투 엔드 추적은 하나 이상의 범위로 구성됩니다.

기간은 작업 이름, 작업의 시작 시간 및 기간이 있는 논리 작업 단위를 나타냅니다. 기간은 중첩되어 인과 관계를 모델링하도록 주문될 수 있습니다.

1.3.4.1. 분산 추적 개요

서비스 소유자는 분산 추적을 사용하여 서비스 아키텍처에 대한 통찰력을 수집하기 위해 서비스를 계측할 수 있습니다. 분산 추적을 사용하여 최신 클라우드 네이티브, 마이크로서비스 기반 애플리케이션의 구성 요소 간 상호 작용을 모니터링, 네트워크 프로파일링 및 문제 해결할 수 있습니다.

분산 추적을 사용하면 다음 기능을 수행할 수 있습니다.

- 분산 트랜잭션 모니터링

- 성능 및 대기 시간 최적화

- 근본 원인 분석 수행

Red Hat OpenShift distributed tracing은 다음 두 가지 주요 구성 요소로 구성됩니다.

- Red Hat OpenShift 분산 추적 플랫폼 - 이 구성 요소는 오픈 소스 Jaeger 프로젝트를 기반으로 합니다.

- Red Hat OpenShift 분산 추적 데이터 수집 - 이 구성 요소는 오픈 소스 OpenTelemetry 프로젝트를 기반으로 합니다.

이러한 두 구성 요소는 모두 벤더 중립 OpenTracing API 및 계측을 기반으로 합니다.

1.3.4.2. Red Hat OpenShift distributed tracing 아키텍처

Red Hat OpenShift distributed tracing은 추적 데이터를 수집, 저장 및 표시하기 위해 함께 작동하는 여러 구성 요소로 구성됩니다.

Red Hat OpenShift 분산 추적 플랫폼 - 이 구성 요소는 오픈 소스 Jaeger 프로젝트를 기반으로 합니다.

- 클라이언트 (Jaeger 클라이언트, Tracer, Reporter, 조정된 애플리케이션, 클라이언트 라이브러리)- 분산 추적 플랫폼 클라이언트는 OpenTracing API의 언어별 구현입니다. 수동으로 또는 이미 OpenTracing과 통합된 Camel(Fuse), Spring Boot(RHOAR), MicroProfile(RHOAR/T©tail), Wildfly(EAP) 등의 다양한 기존 오픈 소스 프레임워크를 사용하여 분산 추적에 대해 애플리케이션을 조정하는 데 사용할 수 있습니다.

- 에이전트 (Jaeger 에이전트, 서버 대기열, 프로세서 작업자) - 분산 추적 플랫폼 에이전트가 UDP(User Datagram Protocol)를 통해 전송되는 기간을 수신 대기하는 네트워크 데몬이며 이 데몬은 수집기로 일괄 처리 및 전송합니다. 에이전트는 조정된 애플리케이션과 동일한 호스트에 배치되어야 합니다. 일반적으로 Kubernetes와 같은 컨테이너 환경에서 사이드카를 보유하여 수행됩니다.

- Jaeger 수집기 ( Collector, Queue, Workers) - Jaeger 수집기는 기간을 수신하여 처리를 위해 내부 큐에 배치합니다. 이를 통해 Jaeger 수집기는 기간이 스토리지로 이동할 때까지 기다리는 대신 클라이언트/에이전트로 즉시 돌아갈 수 있습니다.

- 스토리지(데이터 저장소) - 수집기에는 영구 스토리지 백엔드가 필요합니다. Red Hat OpenShift 분산 추적 플랫폼에는 범위 스토리지를 위한 플러그형 메커니즘이 있습니다. 이 릴리스에서 지원되는 유일한 스토리지는 Elasticsearch입니다.

- 쿼리(쿼리 서비스) - 쿼리는 스토리지에서 추적을 검색하는 서비스입니다.

- Ingester (Ingester Service) - Red Hat OpenShift distributed tracing은 수집기와 실제 Elasticsearch 백업 스토리지 간의 버퍼로 Apache Kafka를 사용할 수 있습니다. Ingester는 Kafka에서 데이터를 읽고 Elasticsearch 스토리지 백엔드에 쓰는 서비스입니다.

- Jaeger 콘솔 - Red Hat OpenShift 분산 추적 플랫폼 사용자 인터페이스를 통해 분산 추적 데이터를 시각화할 수 있습니다. 검색 페이지에서 추적을 찾고 개별 추적을 구성하는 기간의 세부 사항을 확인할 수 있습니다.

Red Hat OpenShift 분산 추적 데이터 수집 - 이 구성 요소는 오픈 소스 OpenTelemetry 프로젝트를 기반으로 합니다.

- OpenTelemetry Collector - OpenTelemetry 수집기는 원격 분석 데이터를 수신, 처리 및 내보낼 수 있는 공급업체와 무관한 방법입니다. OpenTelemetry 수집기는 하나 이상의 오픈 소스 또는 상용 백엔드로 보내는 Jaeger 및 Prometheus와 같은 오픈 소스 관찰성 데이터 형식을 지원합니다. 수집기는 기본 위치 계측 라이브러리로 Telemetry 데이터를 내보냅니다.

1.3.4.3. Red Hat OpenShift distributed tracing 기능

Red Hat OpenShift distributed tracing은 다음과 같은 기능을 제공합니다.

- Kiali와의 통합 - 올바르게 구성된 경우 Kiali 콘솔에서 분산 추적 데이터를 볼 수 있습니다.

- 높은 확장성 - 분산 추적 백엔드는 단일 장애 지점이 없고 비즈니스 요구에 맞게 확장할 수 있도록 설계되었습니다.

- 분산 컨텍스트 전파 - 다양한 구성 요소의 데이터를 함께 연결하여 완전한 엔드 투 엔드 추적을 만들 수 있습니다.

- Zipkin과의 역호환성 - Red Hat OpenShift distributed tracing에는 Zipkin을 대체하는 데 사용할 수 있는 API가 있지만 Red Hat은 이 릴리스에서 Zipkin 호환성을 지원하지 않습니다.

1.3.5. 다음 단계

- OpenShift Container Platform 환경에 Red Hat OpenShift Service Mesh를 설치할 준비를 합니다.

1.4. 서비스 메시 배포 모델

Red Hat OpenShift Service Mesh는 비즈니스 요구 사항에 가장 적합한 다양한 방식으로 결합할 수 있는 여러 가지 배포 모델을 지원합니다.

1.4.1. 단일 메시 배포 모델

가장 간단한 Istio 배포 모델은 단일 메시입니다.

Kubernetes는 my namespace 네임스페이스에서 하나의 서비스 이름만 myservice 로 지정할 수 있으므로 메시 내의 서비스 이름은 고유해야 합니다. 그러나 동일한 네임스페이스의 워크로드 간에 서비스 계정 이름을 공유할 수 있으므로 워크로드 인스턴스는 공통 ID를 공유할 수 있습니다.

1.4.2. 단일 테넌시 배포 모델

Istio에서 테넌트는 배포된 워크로드 집합에 대한 공통 액세스 및 권한을 공유하는 사용자 그룹입니다. 테넌트를 사용하여 여러 팀 간에 격리 수준을 제공할 수 있습니다. istio.io 또는 서비스 리소스에 대한 NetworkPolicies,AuthorizationPolicies 및 exportTo 주석을 사용하여 다양한 테넌트에 대한 액세스를 분리할 수 있습니다.

단일 테넌트, 클러스터 전체 서비스 메시 컨트롤 플레인 구성은 Red Hat OpenShift Service Mesh 버전 1.0에서 더 이상 사용되지 않습니다. Red Hat OpenShift Service Mesh의 기본값은 다중 테넌트 모델입니다.

1.4.3. 멀티 테넌트 배포 모델

Red Hat OpenShift Service Mesh는 기본적으로 멀티 테넌시용으로 구성된 ServiceMeshControlPlane 을 설치합니다. Red Hat OpenShift Service Mesh는 다중 테넌트 Operator를 사용하여 Service Mesh Control Plane 라이프사이클을 관리합니다. 메시 내에서 테넌시에는 네임스페이스가 사용됩니다.

Red Hat OpenShift Service Mesh는 ServiceMeshControlPlane 리소스를 사용하여 기본적으로 리소스가 포함된 네임스페이스로 제한된 메시 설치를 관리합니다. ServiceMeshMemberRoll 및 ServiceMeshMember 리소스를 사용하여 추가 네임스페이스를 메시에 포함합니다. 네임스페이스는 단일 메시에만 포함될 수 있으며 여러 메시를 단일 OpenShift 클러스터에 설치할 수 있습니다.

일반적인 서비스 메시 배포에서는 단일 서비스 메시 컨트롤 플레인을 사용하여 메시의 서비스 간 통신을 구성합니다. Red Hat OpenShift Service Mesh는 하나의 컨트롤 플레인과 테넌트당 하나의 메시가 있고 클러스터 내에 여러 개의 독립적인 컨트롤 플레인이 있을 수 있는 "소프트 멀티 테넌시"를 지원합니다. 다중 테넌트 배포는 서비스 메시에 액세스하고 다른 컨트롤 플레인 인스턴스에서 서비스 메시를 격리할 수 있는 프로젝트를 지정합니다.

클러스터 관리자는 모든 Istio 컨트롤 플레인에서 제어 및 가시성을 확보하는 반면 테넌트 관리자는 특정 서비스 메시, Kiali 및 Jaeger 인스턴스에 대해서만 제어합니다.

팀에게 지정된 네임스페이스 또는 네임스페이스 세트에만 워크로드를 배포할 수 있는 권한을 부여할 수 있습니다. 서비스 메시 관리자가 mesh-user 역할을 부여하면 ServiceMeshMember 리소스를 생성하여 ServiceMeshMemberRoll 에 네임스페이스를 추가할 수 있습니다.

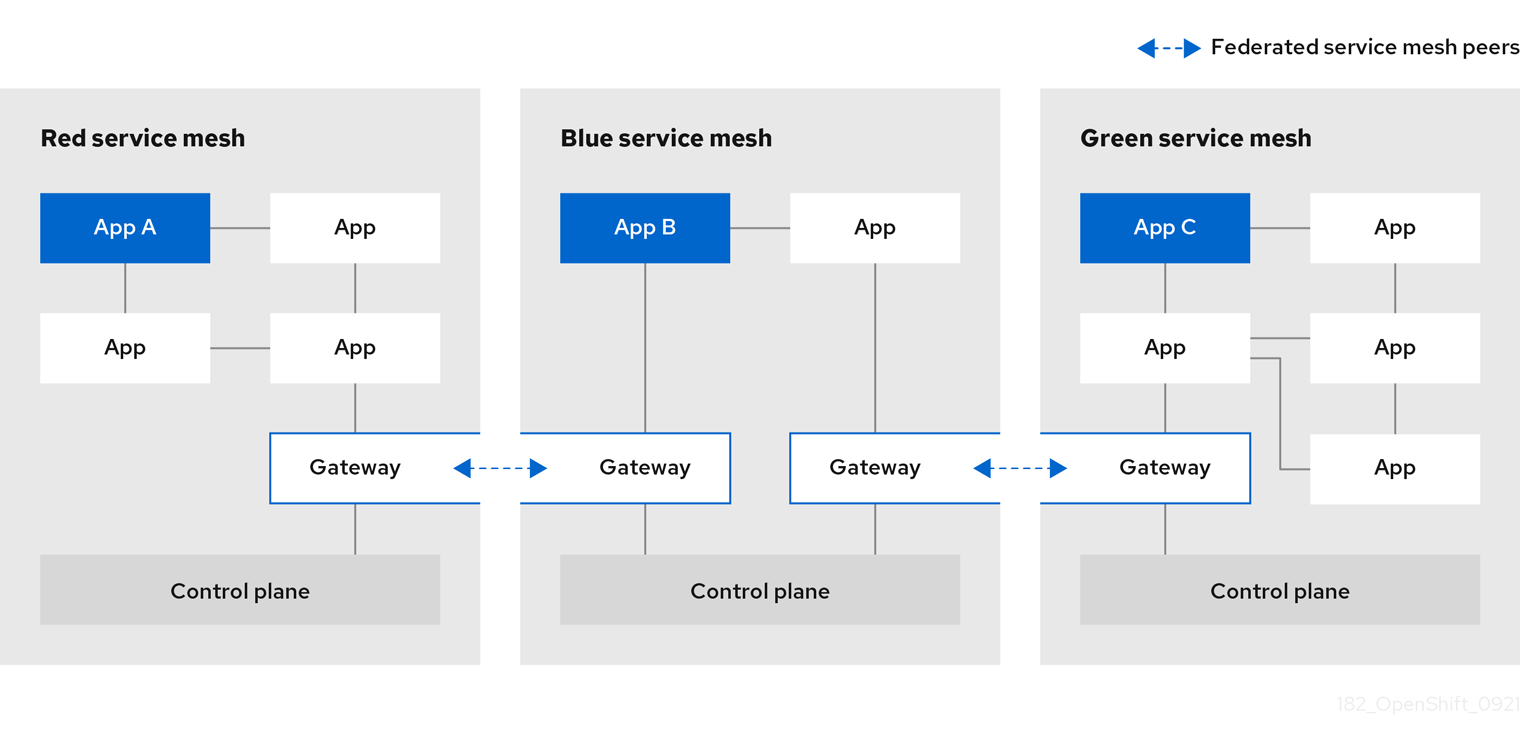

1.4.4. Multimesh 또는 페더레이션 배포 모델

Federation 은 별도의 관리 도메인에서 관리되는 개별 메시 간에 서비스와 워크로드를 공유할 수 있는 배포 모델입니다.

Istio 다중 클러스터 모델에는 개별 메시가 상주하는 모든 Kubernetes API 서버에 대한 메시와 원격 액세스 간의 높은 수준의 신뢰가 필요합니다. Red Hat OpenShift Service Mesh 페더레이션은 메시 간에 최소 의 신뢰성을 가정하는 서비스 메시의 다중 클러스터 구현에 관심이 있는 접근 방식을 취합니다.

연결된 메시는 단일 메시로 동작하는 메시 그룹입니다. 각 메시의 서비스는 고유한 서비스(예: 다른 메시에서 서비스를 추가하여 서비스를 추가하는)일 수 있으며, 메시 전체에서 동일한 서비스에 추가 워크로드를 제공하여 고가용성 또는 두 가지 조합을 제공할 수 있습니다. 페더레이션 메시에 가입된 모든 메시는 개별적으로 관리되므로 페더레이션의 다른 메시에서 내보내고 가져오는 서비스를 명시적으로 구성해야 합니다. 인증서 생성, 지표 및 추적 컬렉션과 같은 지원 기능은 해당 메시에서 로컬로 유지됩니다.

1.5. 서비스 메시 및 Istio 차이점

Red Hat OpenShift Service Mesh는 OpenShift Container Platform에 배포할 때 추가 기능을 제공하거나, 차이점을 처리하기 위한 Istio 설치와는 다릅니다.

1.5.1. Istio와 Red Hat OpenShift Service Mesh 간의 차이점

다음 기능은 서비스 메시와 Istio에서 다릅니다.

1.5.1.1. 명령줄 도구

Red Hat OpenShift Service Mesh의 명령줄 도구는 oc입니다. Red Hat OpenShift Service Mesh는 istioctl을 지원하지 않습니다.

1.5.1.2. 설치 및 업그레이드

Red Hat OpenShift Service Mesh는 Istio 설치 프로필을 지원하지 않습니다.

Red Hat OpenShift Service Mesh는 서비스 메시의 카나리아 업그레이드를 지원하지 않습니다.

1.5.1.3. 자동 삽입

업스트림 Istio 커뮤니티 설치는 레이블을 지정한 프로젝트 내의 pod에 사이드카를 자동으로 삽입합니다.

Red Hat OpenShift Service Mesh는 사이드카를 Pod에 자동으로 삽입하지 않지만 프로젝트에 레이블을 지정하지 않고 주석을 사용하여 삽입해야 합니다. 이 방법은 더 적은 권한이 필요하며, builder pod와 같은 다른 OpenShift 기능과 충돌하지 않습니다. 자동 삽입을 활성화하려면 자동 사이드카 삽입 섹션에 설명된 대로 sidecar.istio.io/inject 주석을 지정합니다.

표 1.4. 사이드카 삽입 라벨 및 주석 설정

| 업스트림 Istio | Red Hat OpenShift Service Mesh | |

|---|---|---|

| 네임스페이스 라벨 | "활성화" 및 "비활성화" 지원 | "비활성화" 지원 |

| Pod 라벨 | "true" 및 "false" 지원 | 지원되지 않음 |

| Pod 주석 | "false"만 지원 | "true" 및 "false" 지원 |

1.5.1.4. Istio 역할 기반 액세스 제어 기능

역할 기반 액세스 제어(RBAC)는 서비스에 대한 액세스를 제어하는 데 사용할 수 있는 메커니즘을 제공합니다. 사용자 이름별로, 또는 속성 집합을 지정하여 제목을 식별하고 그에 따라 액세스 제어를 적용할 수 있습니다.

업스트림 Istio 커뮤니티 설치에는 정확한 헤더 일치를 수행하거나, 헤더에서 와일드카드를 일치시키거나, 특정 접두사 또는 접미사가 포함된 헤더를 확인하는 옵션이 포함되어 있습니다.

Red Hat OpenShift Service Mesh는 정규식을 사용하여 요청 헤더를 일치시키는 기능을 확장합니다. 정규식이 있는 request.regex.headers의 속성 키를 지정합니다.

요청 헤더와 일치하는 업스트림 Istio 커뮤니티 예

apiVersion: security.istio.io/v1beta1

kind: AuthorizationPolicy

metadata:

name: httpbin-usernamepolicy

spec:

action: ALLOW

rules:

- when:

- key: 'request.regex.headers[username]'

values:

- "allowed.*"

selector:

matchLabels:

app: httpbin

1.5.1.5. OpenSSL

Red Hat OpenShift Service Mesh는 BoringSSL을 OpenSSL로 대체합니다. OpenSSL은 SSL(Secure Sockets Layer) 및 TLS(Transport Layer Security) 프로토콜의 오픈 소스 구현이 포함된 소프트웨어 라이브러리입니다. Red Hat OpenShift Service Mesh 프록시 바이너리는 기본 Red Hat Enterprise Linux 운영 체제에서 OpenSSL 라이브러리(libssl 및 libcrypto)를 동적으로 연결합니다.

1.5.1.6. 외부 워크로드

Red Hat OpenShift Service Mesh는 베어 메탈 서버에서 OpenShift 외부에서 실행되는 가상 머신과 같은 외부 워크로드를 지원하지 않습니다.

1.5.1.7. 가상 머신 지원

OpenShift Virtualization을 사용하여 OpenShift에 가상 머신을 배포할 수 있습니다. 그런 다음 mTLS 또는 AuthorizationPolicy와 같은 메시 정책을 메시의 일부인 다른 Pod와 마찬가지로 이러한 가상 머신에 적용할 수 있습니다.

1.5.1.8. 구성 요소 수정

- maistra-version 레이블이 모든 리소스에 추가되었습니다.

- 모든 Ingress 리소스가 OpenShift Route 리소스로 변환되었습니다.

- Grafana, distributed tracing(Jaeger) 및 Kiali는 기본적으로 활성화되어 OpenShift 경로를 통해 노출됩니다.

- Godebug가 모든 템플릿에서 제거됨

-

istio-multiServiceAccount과 ClusterRoleBinding,istio-readerClusterRole이 제거되었습니다.

1.5.1.9. Envoy 필터

Red Hat OpenShift Service Mesh는 명시적으로 문서화된 경우를 제외하고 EnvoyFilter 구성을 지원하지 않습니다. 기본 Envoy API와의 긴밀한 결합으로 인해 이전 버전과의 호환성을 유지할 수 없습니다. EnvoyFilter 패치는 Istio에서 생성한 Envoy 구성의 형식에 매우 민감합니다. Istio에서 생성한 구성이 변경되면 EnvoyFilter 의 애플리케이션을 중단할 수 있습니다.

1.5.1.10. Envoy 서비스

Red Hat OpenShift Service Mesh는 QUIC 기반 서비스를 지원하지 않습니다.

1.5.1.11. Istio CNI(컨테이너 네트워크 인터페이스)

Red Hat OpenShift Service Mesh에는 CNI 플러그인이 포함되어 있으며, 이것은 애플리케이션 Pod 네트워킹을 구성할 수 있는 대체 방법을 제공합니다. CNI 플러그인은 상승된 권한으로 SCC(보안 컨텍스트 제약 조건)에 대한 서비스 계정 및 프로젝트 액세스 권한을 부여할 필요가 없도록 init-container 네트워크 구성을 대체합니다.

1.5.1.12. 글로벌 mTLS 설정

Red Hat OpenShift Service Mesh는 메시 내에서 상호 TLS 인증(mTLS)을 활성화 또는 비활성화하는 PeerAuthentication 리소스를 생성합니다.

1.5.1.13. 게이트웨이

Red Hat OpenShift Service Mesh는 기본적으로 수신 및 송신 게이트웨이를 설치합니다. 다음 설정을 사용하여 ServiceMeshControlPlane (SMCP) 리소스에서 게이트웨이 설치를 비활성화할 수 있습니다.

-

spec.gateways.enabled=false를 사용하여 수신 및 송신 게이트웨이를 모두 비활성화합니다. -

spec.gateways.ingress.enabled=false를 사용하여 수신 게이트웨이를 비활성화합니다. -

spec.gateways.egress.enabled=false를 사용하여 송신 게이트웨이를 비활성화합니다.

Operator는 기본 게이트웨이에 주석을 달아 Red Hat OpenShift Service Mesh Operator에 의해 생성되고 관리됨을 나타냅니다.

1.5.1.14. 다중 클러스터 구성

Red Hat OpenShift Service Mesh는 다중 클러스터 구성을 지원하지 않습니다.

1.5.1.15. 사용자 정의 인증서 서명 요청(CSR)

Kubernetes CA(인증 기관)를 통해 CSR을 처리하도록 Red Hat OpenShift Service Mesh를 구성할 수 없습니다.

1.5.1.16. Istio 게이트웨이 경로

Istio 게이트웨이의 OpenShift 경로는 Red Hat OpenShift Service Mesh에서 자동으로 관리됩니다. Istio 게이트웨이가 서비스 메시 내부에서 생성, 업데이트 또는 삭제될 때마다 OpenShift 경로가 생성, 업데이트 또는 삭제됩니다.

IOR(Istio OpenShift Routing)이라는 Red Hat OpenShift Service Mesh Control Plane 구성 요소는 게이트웨이 경로를 동기화합니다. 자세한 내용은 자동 경로 생성을 참조하십시오.

1.5.1.16.1. catch-all 도메인

catch-all 도메인("*")은 지원되지 않습니다. 게이트웨이 정의에서 이 도메인이 발견되면 Red Hat OpenShift Service Mesh는 경로를 생성하지만 기본 호스트 이름을 만들기 위해 OpenShift에 의존합니다. 즉, 새로 생성된 경로는 catch-all ("*") 경로가 아니며, 대신 r<route-name>[-<project>].<suffix> 형식의 호스트 이름이 있습니다. 기본 호스트 이름이 작동하는 방식과 cluster-admin이 이를 사용자 정의할 수 있는 방법에 대한 자세한 내용은 OpenShift Container Platform 설명서를 참조하십시오. Red Hat OpenShift Dedicated를 사용하는 경우 Red Hat OpenShift Dedicated에서 dedicated-admin 역할을 참조하십시오.

1.5.1.16.2. 하위 도메인

하위 도메인(예: "*.domain.com")이 지원됩니다. 그러나 이 기능은 OpenShift Container Platform에서 기본적으로 활성화되어 있지 않습니다. 즉, Red Hat OpenShift Service Mesh는 하위 도메인이 있는 경로를 생성하지만 OpenShift Container Platform이 이것을 활성화하도록 구성된 경우에만 적용됩니다.

1.5.1.16.3. TLS(Transport layer security)

TLS(Transport Layer Security)가 지원됩니다. 즉, 게이트웨이에 tls 섹션이 포함된 경우 OpenShift 경로는 TLS를 지원하도록 구성됩니다.

추가 리소스

1.5.2. 다중 테넌트 설치

업스트림 Istio는 하나의 테넌트 접근법을 사용하지만 Red Hat OpenShift Service Mesh는 클러스터 내에서 여러 개의 독립적인 컨트롤 플레인을 지원합니다. Red Hat OpenShift Service Mesh는 다중 테넌트 연산자를 사용하여 컨트롤 플레인 라이프사이클을 관리합니다.

Red Hat OpenShift Service Mesh는 기본적으로 다중 테넌트 컨트롤 플레인을 설치합니다. 서비스 메시에 액세스할 수 있는 프로젝트를 지정하고 다른 컨트롤 플레인 인스턴스에서 서비스 메시를 분리합니다.

1.5.2.1. 멀티 테넌시 대 클러스터 전체 설치

다중 테넌트 설치와 클러스터 전체 설치의 주요 차이점은 istod에서 사용하는 권한 범위입니다. 구성 요소는 더 이상 클러스터 범위의 역할 기반 액세스 제어(RBAC) 리소스 ClusterRoleBinding을 사용하지 않습니다.

ServiceMeshMemberRoll members 목록에 있는 모든 프로젝트는 컨트롤 플레인 배포와 관련된 각 서비스 계정에 대해 RoleBinding을 가지며, 각 컨트롤 플레인 배포는 해당하는 멤버 프로젝트만 감시합니다. 각 멤버 프로젝트에는 maistra.io/member-of 레이블이 추가됩니다. 여기서 member-of 값은 컨트롤 플레인 설치가 포함된 프로젝트입니다.

Red Hat OpenShift Service Mesh는 각 멤버 프로젝트를 구성하여 자체, 컨트롤 플레인 및 기타 멤버 프로젝트 간의 네트워크 액세스를 보장합니다. 정확한 구성은 OpenShift Container Platform 소프트웨어 정의 네트워킹(SDN)이 구성된 방법에 따라 다릅니다. 자세한 내용은 OpenShift SDN 정보를 참조하십시오.

OpenShift Container Platform 클러스터가 SDN 플러그인을 사용하도록 구성된 경우:

NetworkPolicy: Red Hat OpenShift Service Mesh는 각 멤버 프로젝트에서NetworkPolicy리소스를 생성하여 다른 멤버 및 컨트롤 플레인에서 모든 포드로 수신할 수 있습니다. Service Mesh에서 멤버를 제거하면 이NetworkPolicy리소스는 프로젝트에서 삭제됩니다.참고또한 멤버 프로젝트 전용 수신으로 제한합니다. 멤버 외 프로젝트에서 수신이 필요한 경우 해당 트래픽을 허용하기 위해

NetworkPolicy를 생성해야 합니다.-

다중 테넌트: Red Hat OpenShift Service Mesh는 각 멤버 프로젝트의

NetNamespace를 컨트롤 플레인 프로젝트의NetNamespace에 결합합니다(ocadm pod-network join-projects --to control-plane-project member-project). 서비스 메시에서 멤버를 제거하면 해당NetNamespace가 컨트롤 플레인과 분리됩니다(oc adm pod-network isolate-projects member-project실행과 동일). - 서브넷: 추가 구성이 수행되지 않습니다.

1.5.2.2. 클러스터 범위 리소스

업스트림 Istio에는 의존하는 두 개의 클러스터 범위 리소스가 있습니다. MeshPolicy 및 ClusterRbacConfig 이는 다중 테넌트 클러스터와 호환되지 않으며 아래에 설명된 대로 교체되었습니다.

- ServiceMeshPolicy는 컨트롤 플레인 전체의 인증 정책 구성을 위해 MeshPolicy를 대체합니다. 이는 컨트롤 플레인과 동일한 프로젝트에서 생성되어야 합니다.

- ServicemeshRbacConfig는 컨트롤 플레인 전체 역할 기반 액세스 제어 구성을 위해 ClusterRbacConfig 를 대체합니다. 이는 컨트롤 플레인과 동일한 프로젝트에서 생성되어야 합니다.

1.5.3. Kiali 및 서비스 메시

OpenShift Container Platform의 서비스 메시를 통해 Kiali를 설치하는 것은 여러 가지 면에서 커뮤니티 Kiali 설치와 다릅니다. 이러한 수정은 OpenShift Container Platform에 배포할 때 문제를 해결하거나, 추가 기능을 제공하거나, 차이점을 처리하기 위해 필요한 경우가 있습니다.

- Kiali는 기본적으로 활성화되어 있습니다.

- Ingress는 기본적으로 활성화되어 있습니다.

- Kiali ConfigMap이 업데이트되었습니다.

- Kiali의 ClusterRole 설정이 업데이트되었습니다.

-

서비스 메시 또는 Kiali Operator가 변경 사항을 덮어쓸 수 있으므로 ConfigMap을 편집하지 마십시오. Kiali Operator가 관리하는 파일에는

kiali.io/레이블 또는 주석이 있습니다. Operator 파일을 업데이트하려면cluster-admin권한이 있는 사용자로 제한해야 합니다. Red Hat OpenShift Dedicated를 사용하는 경우 Operator 파일을 업데이트하려면dedicated-admin권한이 있는 사용자로 제한해야 합니다.

1.5.4. 분산 추적 및 서비스 메시

OpenShift Container Platform에서 Service Mesh를 사용하여 분산 추적 플랫폼을 설치하는 것은 여러 가지 면에서 커뮤니티 Jaeger 설치와 다릅니다. 이러한 수정은 OpenShift Container Platform에 배포할 때 문제를 해결하거나, 추가 기능을 제공하거나, 차이점을 처리하기 위해 필요한 경우가 있습니다.

- 서비스 메시에 대해 기본적으로 분산 추적이 활성화되어 있습니다.

- Ingress는 기본적으로 서비스 메시에 대해 활성화되어 있습니다.

-

Zipkin 포트 이름의 이름이

jaeger-collector-zipkin(으로 변경되었습니다.http) -

Jaeger는

production또는streaming배포 옵션을 선택할 때 기본적으로 스토리지에 Elasticsearch를 사용합니다. - Istio 커뮤니티 버전은 일반적인 "tracing" 경로를 제공합니다. Red Hat OpenShift Service Mesh는 Red Hat OpenShift distributed tracing Platform Operator가 설치하고 이미 OAuth에 의해 보호되는 "jaeger" 경로를 사용합니다.

- Red Hat OpenShift Service Mesh는 Envoy 프록시에 사이드카를 사용하며 Jaeger 또한 Jaeger 에이전트에 사이드카를 사용합니다. 이 두 가지 사이드카는 별도로 구성되어 있으며 서로 혼동해서는 안 됩니다. 프록시 사이드카는 Pod의 수신 및 송신 트래픽과 관련된 기간을 생성합니다. 에이전트 사이드카는 응용 프로그램에서 발송되는 기간을 수신하여 Jaeger 수집기로 보냅니다.

1.6. 서비스 메시 설치 준비

Red Hat OpenShift Service Mesh를 설치하려면 먼저 OpenShift Container Platform을 구독하고 지원되는 구성에 OpenShift Container Platform을 설치해야 합니다.

1.6.1. 사전 요구 사항

- Red Hat 계정에 유효한 OpenShift Container Platform 서브스크립션을 유지하십시오. 서브스크립션이 없는 경우 영업 담당자에게 자세한 내용을 문의하십시오.

OpenShift Container Platform 4.6 개요 를 검토합니다.

OpenShift Container Platform 버전과 일치하는 OpenShift Container Platform 명령줄 유틸리티(

oc클라이언트 도구) 버전을 설치하고 해당 경로에 추가합니다.- OpenShift Container Platform 4.6을 사용하는 경우 OpenShift CLI 정보를 참조하십시오.

Red Hat OpenShift Service Mesh 라이프사이클 및 지원되는 플랫폼에 대한 자세한 내용은 지원 정책을 참조하십시오.

1.6.2. 지원되는 구성

Red Hat OpenShift Service Mesh의 현재 릴리스에서는 다음 구성이 지원됩니다.

1.6.2.1. 지원되는 플랫폼

Red Hat OpenShift Service Mesh Operator는 ServiceMeshControlPlane 리소스의 여러 버전을 지원합니다. 버전 2.2 Service Mesh Control Planes는 다음 플랫폼 버전에서 지원됩니다.

- Red Hat OpenShift Container Platform 버전 4.9 이상

- Red Hat OpenShift Dedicated 버전 4.

- Azure Red Hat OpenShift (ARO) 버전 4.

- Red Hat OpenShift Service on AWS(ROSA).

1.6.2.2. 지원되지 않는 로깅 구성

명시적으로 지원되지 않는 경우는 다음과 같습니다.

- OpenShift Online은 Red Hat OpenShift Service Mesh에서 지원되지 않습니다.

- Red Hat OpenShift Service Mesh는 Service Mesh가 실행 중인 클러스터 외부에서 마이크로 서비스 관리를 지원하지 않습니다.

1.6.2.3. 지원되는 네트워크 구성

Red Hat OpenShift Service Mesh는 다음과 같은 네트워크 구성을 지원합니다.

- OpenShift-SDN

- OVN-Kubernetes는 OpenShift Container Platform 4.7.32 이상, OpenShift Container Platform 4.8.12 이상 및 OpenShift Container Platform 4.9 이상에서 지원됩니다.

- OpenShift Container Platform에서 인증되고 서비스 메시 준수 테스트를 통과한 타사 CNI(컨테이너 네트워크 인터페이스) 플러그인입니다. 자세한 내용은 Certified OpenShift CNI 플러그인을 참조하십시오.

1.6.2.4. Service Mesh에 지원되는 구성

이번 Red Hat OpenShift Service Mesh 릴리스는 OpenShift Container Platform x86_64, IBM Z 및 IBM Power Systems에서만 사용 가능합니다.

- IBM Z는 Openshift Container Platform 4.6 이상에서만 지원됩니다.

- IBM Power Systems은 OpenShift Container Platform 4.6 이상에서만 지원됩니다.

- 모든 Service Mesh 구성 요소가 단일 OpenShift Container Platform 클러스터에 포함된 구성입니다.

- 가상 머신과 같은 외부 서비스를 통합하지 않는 구성입니다.

-

Red Hat OpenShift Service Mesh는 명시적으로 문서화된 경우를 제외하고

EnvoyFilter구성을 지원하지 않습니다.

1.6.2.5. Kiali에 대해 지원되는 구성

- Kiali 콘솔은 Chrome, Edge, Firefox 또는 Safari 브라우저의 두 가지 최신 릴리스에서만 지원됩니다.

1.6.2.6. 분산 추적에 지원되는 구성

- 사이드카로서의 Jaeger 에이전트는 Jaeger에 대해 지원되는 유일한 구성입니다. 다중 테넌트 설치 또는 OpenShift Dedicated에서는 데몬 세트로 Jaeger가 지원되지 않습니다.

1.6.2.7. 지원되는 WebAssembly 모듈

- 3scale WebAssembly는 제공된 유일한 WebAssembly 모듈입니다. 사용자 정의 WebAssembly 모듈을 생성할 수 있습니다.

1.6.3. 다음 단계

- OpenShift Container Platform 환경에 Red Hat OpenShift Service Mesh를 설치합니다.

1.7. Operator 설치

Red Hat OpenShift Service Mesh를 설치하려면 먼저 OpenShift Container Platform에 필요한 Operator를 설치한 다음 ServiceMeshControlPlane 리소스를 생성하여 컨트롤 플레인을 배포합니다.

이 기본 설치는 기본 OpenShift 설정을 기반으로 구성되며 프로덕션용으로 설계되지 않습니다. 이 기본 설치를 사용하여 설치를 확인한 다음 특정 환경에 대한 서비스 메시를 구성합니다.

사전 요구 사항

- Red Hat OpenShift Service Mesh 설치 준비 프로세스를 읽어 보십시오.

-

cluster-admin역할이 있는 계정. Red Hat OpenShift Dedicated를 사용하는 경우dedicated-admin역할의 계정이 있어야 합니다.

다음 단계에서는 OpenShift Container Platform에 Red Hat OpenShift Service Mesh의 기본 인스턴스를 설치하는 방법을 보여줍니다.

1.7.1. Operator 개요

Red Hat OpenShift Service Mesh에는 다음과 같은 네 가지 Operator가 필요합니다.

- OpenShift Elasticsearch - (선택 사항) 분산 추적 플랫폼과의 추적 및 로깅을 위한 데이터베이스 스토리지를 제공합니다. 오픈 소스 Elasticsearch 프로젝트를 기반으로 합니다.

- Red Hat OpenShift distributed tracing 플랫폼 - 복잡한 분산 시스템의 트랜잭션을 모니터링하고 해결하기 위해 분산 추적을 제공합니다. 오픈 소스 Jaeger 프로젝트를 기반으로 합니다.

- Kiali - 서비스 메시에 대한 가시성을 제공합니다. 단일 콘솔에서 구성을 보고, 트래픽을 모니터링하며 추적을 분석할 수 있습니다. 오픈 소스 Kiali 프로젝트를 기반으로 합니다.

-

Red Hat OpenShift Service Mesh - 애플리케이션을 구성하는 마이크로 서비스를 연결, 보안, 제어 및 관찰할 수 있습니다. Service Mesh Operator는 Service Mesh 구성 요소의 배포, 업데이트 및 삭제를 관리하는

ServiceMeshControlPlane리소스를 정의하고 모니터링합니다. 오픈소스 Istio 프로젝트를 기반으로 합니다.

Operator의 커뮤니티 버전은 설치하지 마십시오. 커뮤니티 Operator는 지원되지 않습니다.

1.7.2. Operator 설치

Red Hat OpenShift Service Mesh를 설치하려면 다음 Operator를 이 순서대로 설치합니다. 각 Operator에 대한 절차를 반복합니다.

- OpenShift Elasticsearch

- Red Hat OpenShift distributed tracing 플랫폼

- Kiali

- Red Hat OpenShift Service Mesh

이미 OpenShift Elasticsearch Operator를 OpenShift 로깅의 일부로 설치한 경우 OpenShift Elasticsearch Operator를 다시 설치할 필요가 없습니다. Red Hat OpenShift distributed tracing platform Operator는 설치된 OpenShift Elasticsearch Operator를 사용하여 Elasticsearch 인스턴스를 생성합니다.

절차

-

cluster-admin역할의 사용자로 OpenShift Container Platform 웹 콘솔에 로그인합니다. Red Hat OpenShift Dedicated를 사용하는 경우dedicated-admin역할의 계정이 있어야 합니다. - OpenShift Container Platform 웹 콘솔에서 Operator → OperatorHub를 클릭합니다.

- Operator 이름을 필터 상자에 입력하고 Operator의 Red Hat 버전을 선택합니다. Operator의 커뮤니티 버전은 지원되지 않습니다.

- 설치를 클릭합니다.

- 각 Operator의 Operator 설치 페이지에서 기본 설정을 수락합니다.

설치를 클릭합니다. 목록에서 다음 Operator에 대한 단계를 반복하기 전에 Operator가 설치될 때까지 기다립니다.

-

OpenShift Elasticsearch Operator는

openshift-operators-redhat네임스페이스에 설치되며 클러스터의 모든 네임스페이스에서 사용할 수 있습니다. -

Red Hat OpenShift distributed tracing 플랫폼은

openshift-distributed-tracing네임스페이스에 설치되며 클러스터의 모든 네임스페이스에서 사용할 수 있습니다. -

Kiali 및 Red Hat OpenShift Service Mesh Operator는

openshift-operators네임스페이스에 설치되고 클러스터의 모든 네임스페이스에서 사용할 수 있습니다.

-

OpenShift Elasticsearch Operator는

- 4개의 Operator를 모두 설치한 후 Operators → 설치된 Operators를 클릭하여 Operator가 설치되었는지 확인합니다.

1.7.3. 다음 단계

Red Hat OpenShift Service Mesh Operator는 Service Mesh Control Plane을 배포할 때까지 다양한 Service Mesh CRD(사용자 정의 리소스 정의)를 생성하지 않습니다. ServiceMeshControlPlane 리소스를 사용하여 서비스 메시 구성 요소를 설치하고 구성합니다. 자세한 내용은 ServiceMeshControlPlane 생성을 참조하십시오.

1.8. ServiceMeshControlPlane 생성

OpenShift Container Platform 웹 콘솔 또는 oc 클라이언트 도구를 사용하여 명령줄에서 ServiceMeshControlPlane(SMCP)의 기본 설치를 배포할 수 있습니다.

이 기본 설치는 기본 OpenShift 설정을 기반으로 구성되며 프로덕션용으로 설계되지 않습니다. 이 기본 설치를 사용하여 설치를 확인한 다음 환경에 ServiceMeshControlPlane을 구성합니다.

ROSA(Red Hat OpenShift Service on AWS)는 리소스를 생성할 수 있는 위치에 추가 제한을 두고 기본 배포가 작동하지 않습니다. ROSA 환경에 SMCP를 배포하기 전에 추가 요구 사항은 AWS의 Red Hat OpenShift Service에 Service Mesh 설치를 참조하십시오.

Service Mesh 문서는 istio-system을 예제 프로젝트로 사용하지만, 모든 프로젝트에 서비스 메시를 배포할 수 있습니다.

1.8.1. 웹 콘솔에서 Service Mesh Control Plane 배포

웹 콘솔을 사용하여 기본 ServiceMeshControlPlane을 배포할 수 있습니다. 이 예제에서 istio-system 은 Service Mesh Control Plane 프로젝트의 이름입니다.

사전 요구 사항

- Red Hat OpenShift Service Mesh Operator가 설치되어 있어야 합니다.

-

cluster-admin역할이 있는 계정.

프로세스

-

cluster-admin역할의 사용자로 OpenShift Container Platform 웹 콘솔에 로그인합니다. Red Hat OpenShift Dedicated를 사용하는 경우dedicated-admin역할의 계정이 있어야 합니다. istio-system이라는 프로젝트를 생성합니다.- 홈 → 프로젝트로 이동합니다.

- 프로젝트 만들기를 클릭합니다.

이름 필드에

istio-system을 입력합니다.ServiceMeshControlPlane리소스는 마이크로 서비스 및 Operator와 별도로 프로젝트에 설치해야 합니다.이 단계에서는

istio-system을 예로 사용하지만 서비스가 포함된 프로젝트와 별도로 모든 프로젝트에 Service Mesh Control Plane을 배포할 수 있습니다.- 생성을 클릭합니다.

- Operators → 설치된 Operator로 이동합니다.

- Red Hat OpenShift Service Mesh Operator를 클릭한 다음 Istio Service Mesh Control Plane을 클릭합니다.

- Istio Service Mesh Control Plane 탭에서 ServiceMeshControlPlane 생성을 클릭합니다.

ServiceMeshControlPlane 생성 페이지에서 기본 Service Mesh Control Plane 버전을 수락하여 제품의 최신 버전에서 사용할 수 있는 기능을 활용합니다. 컨트롤 플레인의 버전에 따라 Operator 버전에 관계없이 사용 가능한 기능을 결정합니다.

나중에

ServiceMeshControlPlane설정을 구성할 수 있습니다. 자세한 내용은 Red Hat OpenShift Service Mesh 구성을 참조하십시오.- 생성을 클릭합니다. Operator는 구성 매개변수를 기반으로 pods, 서비스 및 Service Mesh Control Plane 구성 요소를 생성합니다.

컨트롤 플레인이 올바르게 설치되었는지 확인하려면 Istio Service Mesh Control Plane 탭을 클릭합니다.

- 새 컨트롤 플레인의 이름을 클릭합니다.

- 리소스 탭을 클릭하여 Operator가 생성 및 구성된 Red Hat OpenShift Service Mesh Control Plane 리소스를 확인합니다.

1.8.2. CLI를 사용하여 Service Mesh Control Plane 배포

명령줄에서 기본 ServiceMeshControlPlane을 배포할 수 있습니다.

사전 요구 사항

- Red Hat OpenShift Service Mesh Operator가 설치되어 있어야 합니다.

-

OpenShift CLI(

oc)에 액세스합니다.

프로세스

cluster-admin역할의 사용자로 OpenShift Container Platform CLI에 로그인합니다. Red Hat OpenShift Dedicated를 사용하는 경우dedicated-admin역할의 계정이 있어야 합니다.$ oc login --username=<NAMEOFUSER> https://<HOSTNAME>:6443

istio-system이라는 프로젝트를 생성합니다.$ oc new-project istio-system

다음 예제를 사용하여

istio-installation.yaml이라는ServiceMeshControlPlane파일을 생성합니다. Service Mesh Control Plane의 버전에 따라 Operator 버전에 관계없이 사용 가능한 기능을 결정합니다.버전 2.2 istio-installation.yaml 예

apiVersion: maistra.io/v2 kind: ServiceMeshControlPlane metadata: name: basic namespace: istio-system spec: version: v2.2 tracing: type: Jaeger sampling: 10000 addons: jaeger: name: jaeger install: storage: type: Memory kiali: enabled: true name: kiali grafana: enabled: true다음 명령을 실행하여 서비스 메시 컨트롤 플레인을 배포합니다. 여기서 <

istio_installation.yaml>에는 파일에 대한 전체 경로가 포함됩니다.$ oc create -n istio-system -f <istio_installation.yaml>

Pod 배포 진행 상황을 조사하려면 다음 명령을 실행합니다.

$ oc get pods -n istio-system -w

출력은 다음과 유사합니다.

NAME READY STATUS RESTARTS AGE grafana-b4d59bd7-mrgbr 2/2 Running 0 65m istio-egressgateway-678dc97b4c-wrjkp 1/1 Running 0 108s istio-ingressgateway-b45c9d54d-4qg6n 1/1 Running 0 108s istiod-basic-55d78bbbcd-j5556 1/1 Running 0 108s jaeger-67c75bd6dc-jv6k6 2/2 Running 0 65m kiali-6476c7656c-x5msp 1/1 Running 0 43m prometheus-58954b8d6b-m5std 2/2 Running 0 66m wasm-cacher-basic-8c986c75-vj2cd 1/1 Running 0 65m

1.8.3. CLI를 사용하여 SMCP 설치 검증

명령줄에서 ServiceMeshControlPlane 생성을 검증할 수 있습니다.

프로세스

cluster-admin역할의 사용자로 OpenShift Container Platform CLI에 로그인합니다. Red Hat OpenShift Dedicated를 사용하는 경우dedicated-admin역할의 계정이 있어야 합니다.$ oc login https://<HOSTNAME>:6443

다음 명령을 실행하여 서비스 메시 컨트롤 플레인 설치를 확인합니다. 여기서

istio-system은 Service Mesh Control Plane을 설치한 네임스페이스입니다.$ oc get smcp -n istio-system

STATUS열이ComponentsReady인 경우 설치가 성공적으로 완료되었습니다.NAME READY STATUS PROFILES VERSION AGE basic 10/10 ComponentsReady ["default"] 2.1.1 66m

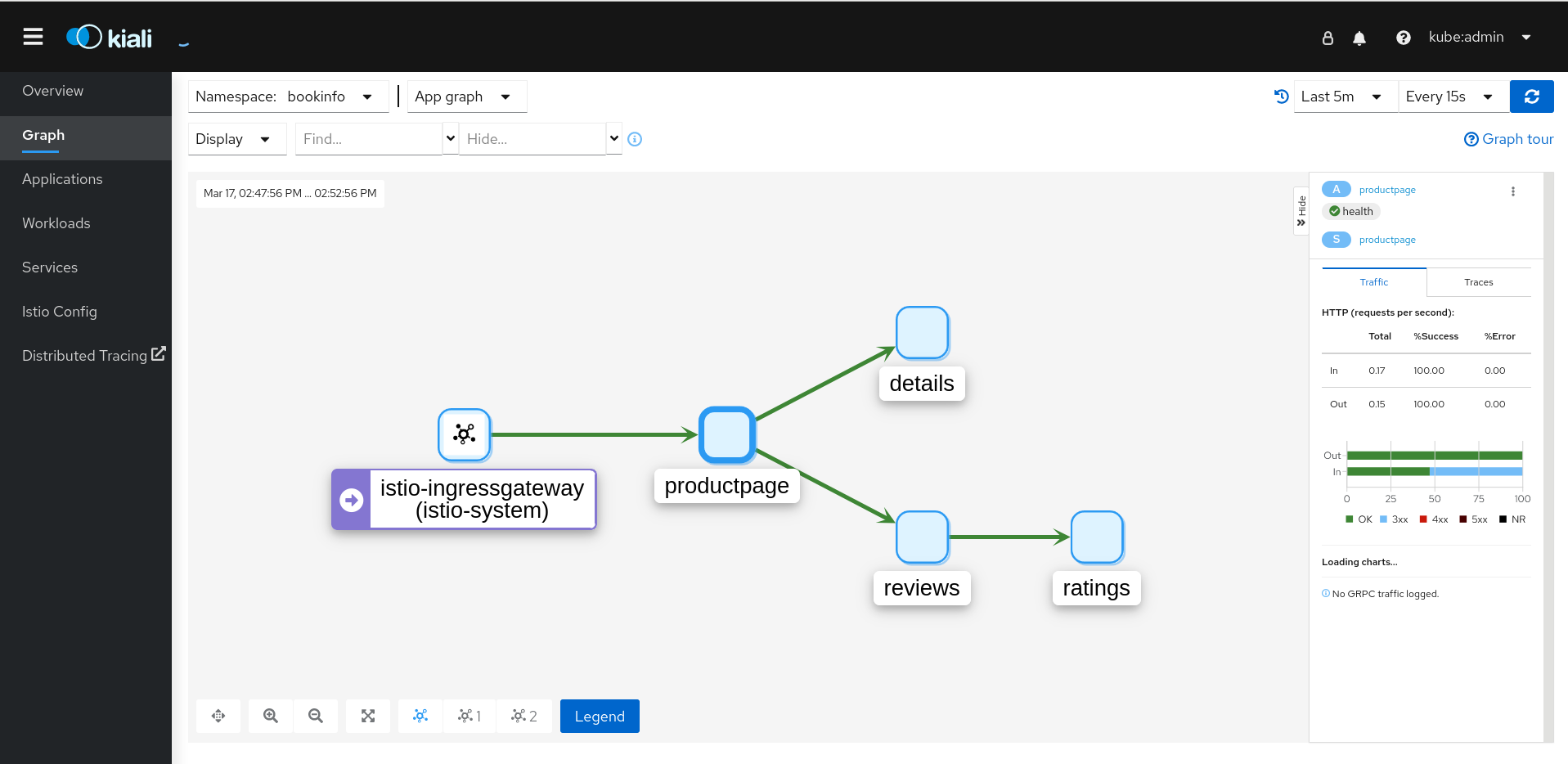

1.8.4. Kiali를 사용하여 SMCP 설치 검증

Kiali 콘솔을 사용하여 서비스 메시 설치를 검증할 수 있습니다. Kiali 콘솔은 서비스 메시 구성 요소가 올바르게 배포 및 구성되는 여러 가지 방법을 제공합니다.

절차

-

OpenShift Container Platform 웹 콘솔에 cluster-admin 권한이 있는 사용자로 로그인합니다. Red Hat OpenShift Dedicated를 사용하는 경우

dedicated-admin역할의 계정이 있어야 합니다. - 네트워킹 → 경로로 이동합니다.

경로 페이지의 네임스페이스 메뉴에서 Service Mesh Control Plane 프로젝트(예:

istio-system)를 선택합니다.Location (위치) 열에는 각 경로의 연결된 주소가 표시됩니다.

- 필요한 경우 필터를 사용하여 Kiali 콘솔의 경로를 찾습니다. 경로 Location (위치)을 클릭하여 콘솔을 시작합니다.

OpenShift로 로그인을 클릭합니다.

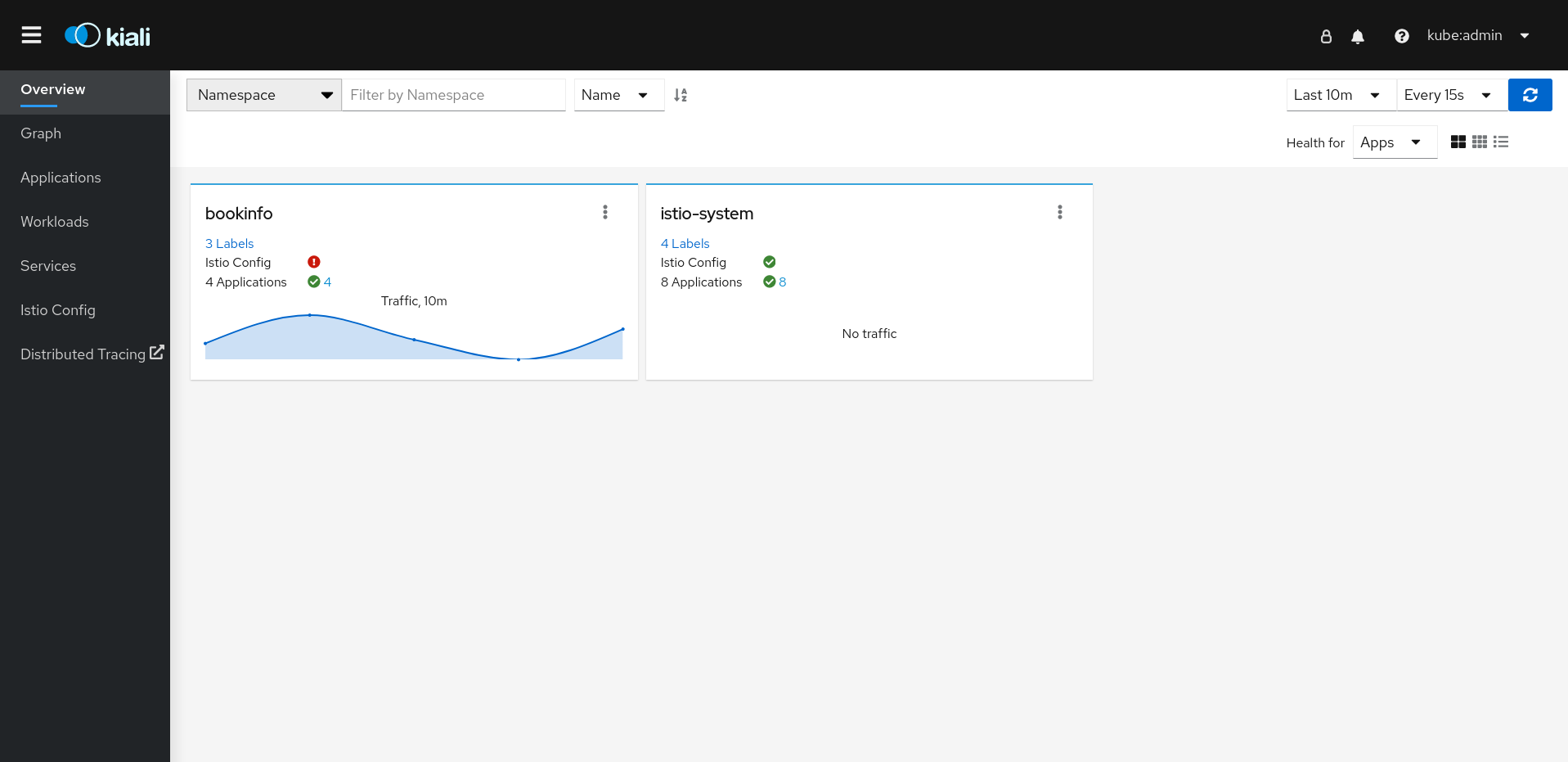

Kiali 콘솔에 처음 로그인하면 볼 권한이 있는 서비스 메시의 모든 네임스페이스를 표시하는 개요 페이지가 표시됩니다. 개요 페이지에 여러 네임스페이스가 표시되면 Kiali에서 상태 또는 검증 문제가 있는 네임스페이스를 먼저 표시합니다.

그림 1.1. Kiali 개요 페이지

각 네임스페이스의 타일은 레이블 수, Istio Config 상태, 애플리케이션 상태 수, 네임스페이스의 트래픽 수 를 표시합니다. 콘솔 설치의 유효성을 검사하고 네임스페이스가 메시에 아직 추가되지 않은 경우

istio-system이외의 데이터가 표시되지 않을 수 있습니다.Kiali에는 특히 Service Mesh Control Plane이 설치된 네임스페이스에 대한 4개의 대시보드가 있습니다. 이러한 대시보드를 보려면 컨트롤 플레인 네임스페이스의 타일에서 옵션 메뉴

를 클릭하고 다음 옵션 중 하나를 선택합니다.

를 클릭하고 다음 옵션 중 하나를 선택합니다. - Istio 메시 대시보드

- Istio 컨트롤 플레인 대시보드

- Istio 성능 대시보드

Istio wsm Exetension 대시보드

그림 1.2. Grafana Istio 컨트롤 플레인 대시보드

Kiali는 Grafana 홈 페이지에서 사용할 수 있는 두 개의 추가 Grafana 대시보드도 설치합니다.

- Istio 워크로드 대시보드

- Istio 서비스 대시보드

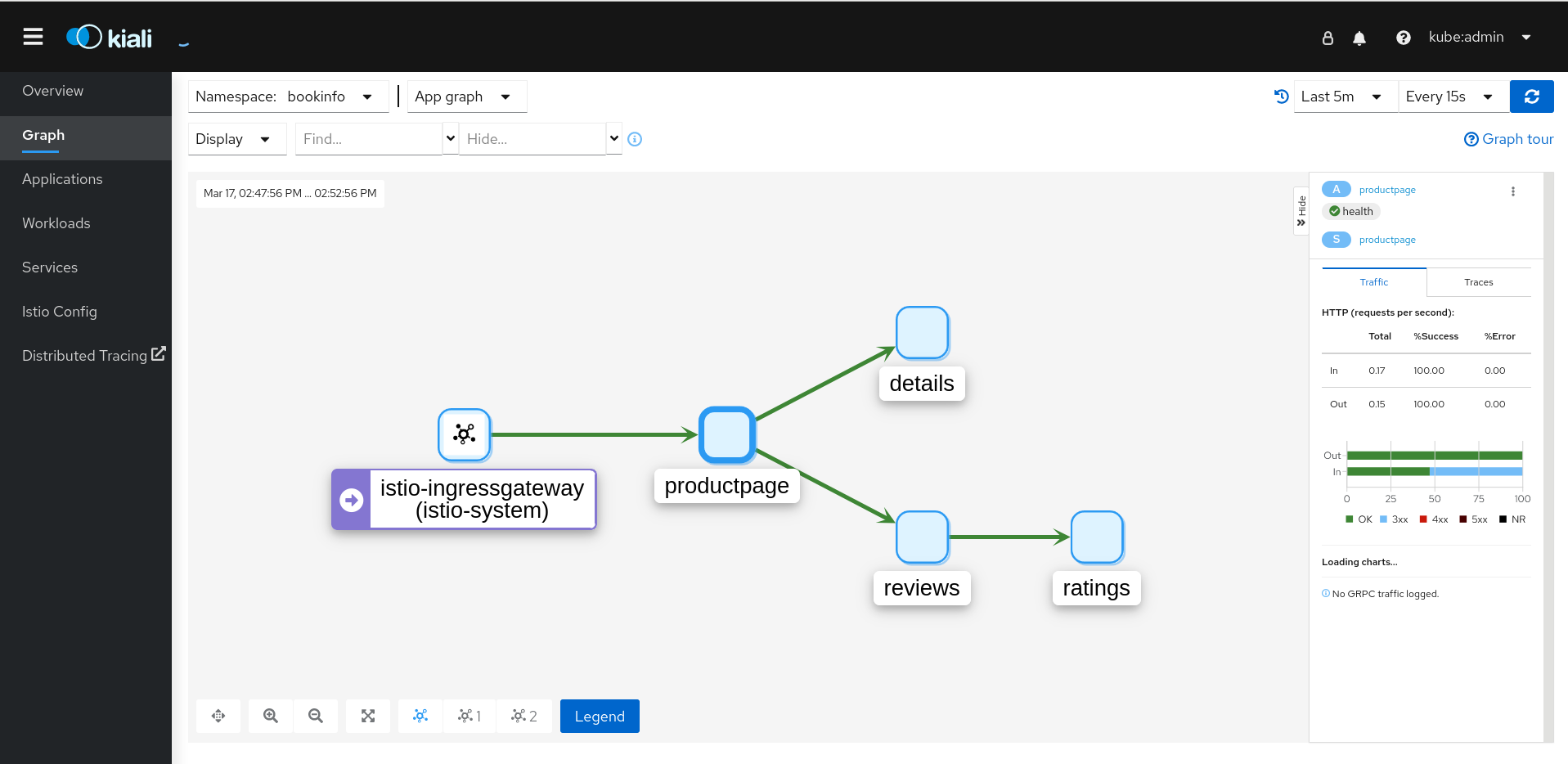

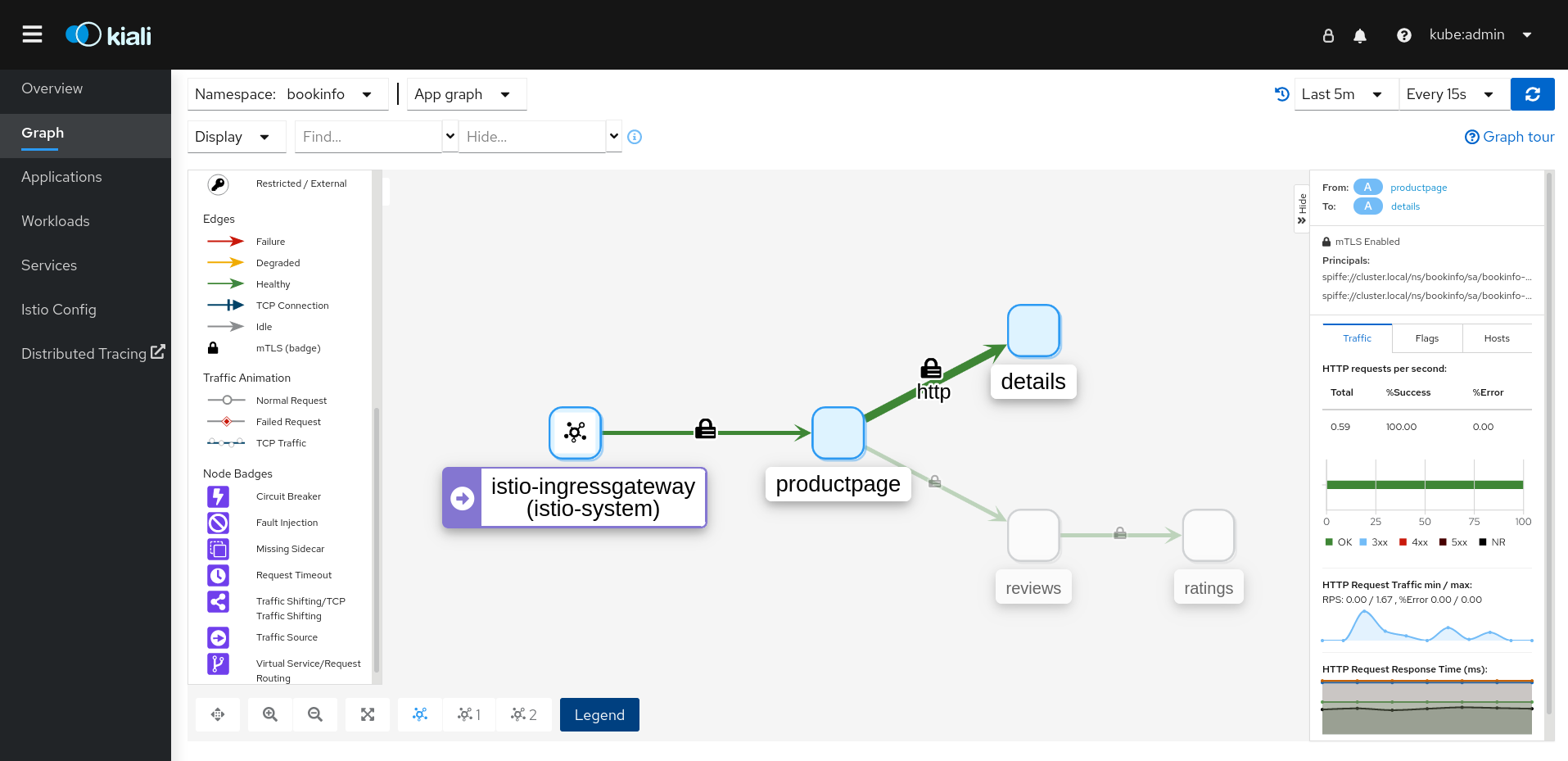

Service Mesh Control Plane 노드를 보려면 그래프 페이지를 클릭하고 메뉴에서

ServiceMeshControlPlane을 설치한 네임스페이스 (예:istio-system)를 선택합니다.- 필요한 경우 Display idle nodes 를 클릭합니다.

- Graph 페이지에 대한 자세한 내용을 보려면 그래프 둘러보기 링크를 클릭합니다.

- 메시 토폴로지를 보려면 네임스페이스 메뉴에서 서비스 메시 멤버 롤에서 하나 이상의 추가 네임스페이스를 선택합니다.

istio-system네임스페이스에서 애플리케이션 목록을 보려면 애플리케이션 페이지를 클릭합니다. Kiali는 애플리케이션의 상태를 표시합니다.- 정보 아이콘 위에 마우스를 가져가면 Details 열에 언급된 추가 정보를 볼 수 있습니다.

istio-system네임스페이스에서 워크로드 목록을 보려면 워크로드 페이지를 클릭합니다. Kiali는 워크로드의 상태를 표시합니다.- 정보 아이콘 위에 마우스를 가져가면 Details 열에 언급된 추가 정보를 볼 수 있습니다.

istio-system네임스페이스에서 서비스 목록을 보려면 서비스 페이지를 클릭합니다. Kiali는 서비스 및 구성의 상태를 표시합니다.- 정보 아이콘 위에 마우스를 가져가면 Details 열에 언급된 추가 정보를 볼 수 있습니다.

istio-system네임스페이스에서 Istio Configuration 오브젝트 목록을 보려면 Istio Config 페이지를 클릭합니다. Kiali는 구성 상태를 표시합니다.- 구성 오류가 있는 경우 행을 클릭하고 Kiali를 클릭하면 오류가 강조 표시된 상태에서 구성 파일을 엽니다.

1.8.5. Red Hat OpenShift Service on AWS(ROSA)에 설치

버전 2.2부터 Red Hat OpenShift Service Mesh는 AWS(ROSA)의 Red Hat OpenShift Service에 설치를 지원합니다. 이 섹션에서는 이 플랫폼에 서비스 메시를 설치할 때 추가 요구 사항을 설명합니다.

1.8.5.1. 설치 위치

Red Hat OpenShift Service Mesh를 설치하고 ServiceMeshControlPlane 을 생성할 때 새 네임스페이스(예: istio-system )를 생성해야 합니다.

1.8.5.2. 필수 Service Mesh Control Plane 구성

ServiceMeshControlPlane 파일의 기본 구성은 ROSA 클러스터에서 작동하지 않습니다. AWS의 Red Hat OpenShift Service에 설치할 때 기본 SMCP를 수정하고 spec.security.identity.type=Thirdparty 를 설정해야 합니다.

ROSA의 ServiceMeshControlPlane 리소스 예

apiVersion: maistra.io/v2

kind: ServiceMeshControlPlane

metadata:

name: basic

namespace: istio-system

spec:

version: v2.2

security:

identity:

type: ThirdParty #required setting for ROSA

tracing:

type: Jaeger

sampling: 10000

policy:

type: Istiod

addons:

grafana:

enabled: true

jaeger:

install:

storage:

type: Memory

kiali:

enabled: true

prometheus:

enabled: true

telemetry:

type: Istiod

1.8.5.3. Kiali 구성에 제한 사항

AWS의 Red Hat OpenShift Service에는 리소스를 생성할 수 있는 추가 제한이 있으며 Red Hat 관리 네임스페이스에 Kiali 리소스를 생성할 수 없습니다.

즉, ROSA 클러스터에서 spec.deployment.accessible_namespaces 에 대한 다음과 같은 공통 설정을 허용하지 않습니다.

-

['**'](모든 네임스페이스) -

default -

codeready-* -

openshift-* -

redhat-*

검증 오류 메시지는 모든 제한된 네임스페이스의 전체 목록을 제공합니다.

ROSA의 Kiali 리소스 예

apiVersion: kiali.io/v1alpha1

kind: Kiali

metadata:

name: kiali

namespace: istio-system

spec:

auth:

strategy: openshift

deployment:

accessible_namespaces: #restricted setting for ROSA

- istio-system

image_pull_policy: ''

ingress_enabled: true

namespace: istio-system

1.8.6. 추가 리소스

Red Hat OpenShift Service Mesh는 클러스터 내에서 여러 개의 독립적인 컨트롤 플레인을 지원합니다. ServiceMeshControlPlane 프로필을 사용하여 재사용 가능한 구성을 생성할 수 있습니다. 자세한 내용은 컨트롤 플레인 프로필 생성을 참조하십시오.

1.8.7. 다음 단계

ServiceMeshMemberRoll 리소스를 만들어 Service Mesh와 연결된 네임스페이스를 지정합니다. 자세한 내용은 서비스 메시에 서비스 추가를 참조하십시오.

1.9. 서비스 메시에 서비스 추가

Operator 및 ServiceMeshControlPlane 리소스를 설치한 후 ServiceMeshMemberRoll 리소스를 생성하고 콘텐츠가 있는 네임스페이스를 지정하여 애플리케이션, 워크로드 또는 서비스를 메시에 추가합니다. ServiceMeshMemberRoll 리소스에 추가할 애플리케이션, 워크로드 또는 서비스가 이미 있는 경우 다음 단계를 사용하십시오. 또는 Bookinfo라는 샘플 애플리케이션을 설치하고 이를 ServiceMeshMemberRoll 리소스에 추가하려면 Bookinfo 예제 애플리케이션 설치를 위한 튜토리얼로 건너뛰어 Red Hat OpenShift Service Mesh에서 애플리케이션이 작동하는 방식을 확인하십시오.

ServiceMeshMemberRoll 리소스에 나열된 항목은 ServiceMeshControlPlane 리소스에서 관리하는 애플리케이션 및 워크플로입니다. 컨트롤 플레인(Service mesh Operator, Istiod, ServiceMeshControlPlane 포함) 및 데이터 플레인(애플리케이션 및 Envoy 프록시 포함)은 별도의 네임스페이스에 있어야 합니다.

ServiceMeshMemberRoll에 네임스페이스를 추가한 후, 해당 네임스페이스의 서비스 또는 pod에 액세스하면 서비스 메시 외부의 호출기에서는 액세스할 수 없습니다.

1.9.1. Red Hat OpenShift Service Mesh 멤버 롤 생성

ServiceMeshMemberRoll 은 Service Mesh Control Plane에 속한 프로젝트를 나열합니다. ServiceMeshMemberRoll에 나열된 프로젝트만 컨트롤 플레인의 영향을 받습니다. 특정 컨트롤 플레인 배포의 멤버 롤에 추가할 때까지 프로젝트는 서비스 메시에 속하지 않습니다.

ServiceMeshControlPlane과 동일한 프로젝트에서 default 라는 ServiceMeshMemberRoll 리소스를 생성해야 합니다. (예: istio-system)

1.9.1.1. 웹 콘솔에서 멤버 롤 생성

웹 콘솔에서 서비스 메시 멤버 롤에 하나 이상의 프로젝트를 추가할 수 있습니다. 이 예제에서 istio-system 은 Service Mesh Control Plane 프로젝트의 이름입니다.

사전 요구 사항

- Red Hat OpenShift Service Mesh Operator 설치 및 검증.

- 서비스 메시에 추가할 기존 프로젝트 목록.

절차

- OpenShift Container Platform 웹 콘솔에 로그인합니다.

메시에 대한 서비스가 아직 없거나 처음부터 시작하려는 경우 애플리케이션에 대한 프로젝트를 생성합니다. Service Mesh Control Plane을 설치한 프로젝트와 달라야 합니다.

- 홈 → 프로젝트로 이동합니다.

- 이름 필드에 이름을 입력합니다.

- 생성을 클릭합니다.

- Operators → 설치된 Operator로 이동합니다.

-

프로젝트 메뉴를 클릭하고 목록에서

ServiceMeshControlPlane리소스가 배포되는 프로젝트를 선택합니다(예:istio-system). - Red Hat OpenShift Service Mesh Operator를 클릭합니다.

- Istio Service Mesh 멤버 목록 탭을 클릭합니다.

- ServiceMeshMemberRoll 만들기를 클릭합니다.

-

Members를 클릭한 다음 Value 필드에 프로젝트 이름을 입력합니다. 여러 프로젝트를 추가할 수 있지만 프로젝트는 하나의

ServiceMeshMemberRoll리소스에만 속할 수 있습니다. - 생성을 클릭합니다.

1.9.1.2. CLI에서 멤버 롤 생성

명령줄의 ServiceMeshMemberRoll에 프로젝트를 추가할 수 있습니다.

사전 요구 사항