클러스터 업데이트

OpenShift Container Platform 클러스터 업데이트

초록

1장. 클러스터 업데이트 개요

웹 콘솔 또는 OpenShift CLI(oc)를 사용하여 단일 작업으로 OpenShift Container Platform 4 클러스터를 업데이트할 수 있습니다.

1.1. OpenShift Container Platform 업데이트 이해

OpenShift Update Service 정보: 인터넷에 액세스할 수 있는 클러스터의 경우 Red Hat은 공용 API 뒤에 있는 호스팅 서비스로 OpenShift Container Platform 업데이트 서비스를 사용하여 무선 업데이트를 제공합니다.

1.2. 업데이트 채널 및 릴리스 이해

채널 및 릴리스 업데이트: 업데이트 채널을 사용하면 업데이트 전략을 선택할 수 있습니다. 업데이트 채널은 OpenShift Container Platform의 마이너 버전에 따라 다릅니다. 업데이트 채널은 릴리스 선택만 제어하며 설치하는 클러스터 버전에는 영향을 미치지 않습니다. OpenShift Container Platform의 특정 버전에 대한 openshift-install 바이너리 파일은 항상 해당 마이너 버전을 설치합니다. 자세한 내용은 다음을 참조하십시오.

1.3. 클러스터 Operator 조건 유형 이해

클러스터 Operator의 상태에는 해당 조건 유형이 포함되어 있으며 Operator의 현재 상태를 알립니다. 다음 정의에서는 몇 가지 일반적인 ClusterOperator 조건 유형 목록을 다룹니다. 추가 조건 유형이 있고 Operator별 언어를 사용하는 Operator가 생략되었습니다.

CVO(Cluster Version Operator)는 클러스터 Operator에서 상태 조건을 수집하여 클러스터 관리자가 OpenShift Container Platform 클러스터의 상태를 더 잘 이해할 수 있도록 합니다.

-

Available: 조건 유형

Available은 Operator가 작동하고 클러스터에서 사용할 수 있음을 나타냅니다. 상태가False이면 피연산자 중 하나 이상이 작동하지 않으며 상태를 사용하려면 관리자가 개입해야 합니다. 진행 중: 상태 유형

진행은 Operator가 새 코드를 적극적으로 롤아웃하거나, 구성 변경 사항을 전파하거나, 다른 하나의 정상 상태에서 다른 상태로 이동하고 있음을 나타냅니다.Operator는 이전에 알려진 상태를 조정할 때 조건 유형

Progressing을True로 보고하지 않습니다. 관찰된 클러스터 상태가 변경되어 Operator가 이에 반응하는 경우 상태가 하나의 정상 상태에서 다른 상태로 이동하므로 상태가True로 다시 보고됩니다.degraded:

Degraded조건 유형은 Operator에 일정 기간 동안 필요한 상태와 일치하지 않는 현재 상태가 있음을 나타냅니다. 기간은 구성 요소에 따라 다를 수 있지만성능이 저하된상태는 Operator 상태에 대한 지속적인 관찰을 나타냅니다. 결과적으로 Operator는Degraded상태로 전환되지 않습니다.한 상태에서 다른 상태로의 전환이

Degraded를 보고하기에 충분한 기간 동안 유지되지 않는 경우 다른 조건 유형이 있을 수 있습니다. Operator는 일반 업데이트 중에Degraded를 보고하지 않습니다. Operator는 최종 관리자 개입이 필요한 영구 인프라 장애에 대한 응답으로Degraded를 보고할 수 있습니다.참고이 상태 유형은 조사 및 조정이 필요할 수 있다는 표시일 뿐입니다. Operator를 사용할 수 있는 경우 성능이 저하된 조건으로

인해사용자 워크로드 장애 또는 애플리케이션 다운 타임이 발생하지 않습니다.Upgradeable:

Upgradeable조건 유형은 Operator가 현재 클러스터 상태에 따라 안전하게 업데이트되는지 여부를 나타냅니다. message 필드에는 클러스터가 성공적으로 업데이트하기 위해 관리자가 수행해야 하는 작업에 대해 사람이 읽을 수 있는 설명이 포함되어 있습니다. CVO는 이 조건이True,Unknown또는 missing인 경우 업데이트를 허용합니다.Upgradeable상태가False인 경우 마이너 업데이트만 영향을 받으며 CVO는 강제하지 않는 한 클러스터에서 영향을 받는 업데이트를 수행하지 않습니다.

1.4. 클러스터 버전 조건 유형 이해

CVO(Cluster Version Operator)는 클러스터 Operator 및 기타 구성 요소를 모니터링하고 클러스터 버전과 해당 Operator의 상태를 모두 수집합니다. 이 상태에는 상태 및 OpenShift Container Platform 클러스터의 현재 상태를 알리는 조건 유형이 포함됩니다.

Available,Progressing, Upgradeable 외에도 클러스터 버전 및 Operator에 영향을 미치는 조건 유형이 있습니다.

-

실패: 클러스터 버전 조건 유형

Failing은 클러스터가 원하는 상태에 도달할 수 없음을 나타내며, 비정상적인 상태이며 관리자가 개입해야 함을 나타냅니다. -

invalid: 클러스터 버전 조건 유형

Invalid는 클러스터 버전이 서버가 작업을 수행하지 못하도록 하는 오류가 있음을 나타냅니다. CVO는 이 조건이 설정된 동안 현재 상태만 조정합니다. -

verifydUpdates: 클러스터 버전 조건 유형 ECDHE

dUpdates는 업스트림 업데이트 서버에서 사용 가능한 업데이트가 검색되었는지 여부를 나타냅니다. 이 조건은 검색 전에알 수 없음이며, 최근 업데이트가 실패했거나 검색할 수 없는경우False또는availableUpdates필드가 최근과 정확하면True입니다. -

ReleaseAccepted: Cluster version condition type

ReleaseAcceptedwith aTruestatus는 이미지 확인 및 사전 조건 검사 중에 실패하지 않고 요청된 릴리스 페이로드가 성공적으로 로드되었음을 나타냅니다. -

ImplicitlyEnabledCapabilities: 클러스터 버전 조건 유형

ImplicitlyEnabledCapabilities와 함께True상태의 경우 사용자가spec.capabilities를 통해 현재 요청하지 않는 활성화된 기능이 있음을 나타냅니다. CVO는 이전에 CVO에서 연결된 리소스를 관리하는 경우 기능 비활성화를 지원하지 않습니다.

1.5. EUS-to-EUS 업데이트 수행 준비

EUS에서 EUS 업데이트 수행 준비: 기본 Kubernetes 설계로 인해 마이너 버전 간의 모든 OpenShift Container Platform 업데이트를 직렬화해야 합니다. OpenShift Container Platform 4.10에서 4.11로 업데이트한 다음 4.12로 업데이트해야 합니다. OpenShift Container Platform 4.10에서 4.12로 직접 업데이트할 수 없습니다. 그러나 EUS (Extended Update Support) 두 가지 버전 간에 업데이트하려는 경우 컨트롤 플레인 호스트가 아닌 단일 재부팅만 수행하면 됩니다. 자세한 내용은 다음을 참조하십시오.

1.6. 웹 콘솔을 사용하여 클러스터 업데이트

웹 콘솔 을 사용하여 클러스터 업데이트: 웹 콘솔 을 사용하여 OpenShift Container Platform 클러스터를 업데이트할 수 있습니다. 다음 단계에서는 마이너 버전에서 클러스터를 업데이트합니다. 마이너 버전 간에 클러스터를 업데이트하는 데 동일한 지침을 사용할 수 있습니다.

1.7. CLI를 사용하여 클러스터 업데이트

CLI를 사용하여 클러스터 업데이트: OpenShift CLI (oc)를 사용하여 마이너 버전에서 OpenShift Container Platform 클러스터를 업데이트할 수 있습니다. 다음 단계에서는 마이너 버전에서 클러스터를 업데이트합니다. 마이너 버전 간에 클러스터를 업데이트하는 데 동일한 지침을 사용할 수 있습니다.

1.8. 카나리아 롤아웃 업데이트 수행

카나리아 롤아웃 업데이트 수행: 작업자 노드에 대한 업데이트 롤아웃을 제어하면 업데이트 프로세스로 인해 애플리케이션이 실패하더라도 전체 업데이트 중에 미션 크리티컬 애플리케이션을 계속 사용할 수 있는지 확인할 수 있습니다. 조직의 필요에 따라 작업자 노드의 작은 하위 집합을 업데이트하고, 일정 기간 동안 클러스터 및 워크로드 상태를 평가한 다음 나머지 노드를 업데이트할 수 있습니다. 이를 카나리아 업데이트라고 합니다. 또는 한 번에 전체 클러스터를 업데이트하기 위해 대규모 유지 관리 기간을 취할 수 없는 경우 호스트 재부팅이 작은 유지 관리 기간으로 필요한 작업자 노드 업데이트를 배치할 수도 있습니다. 다음 절차를 수행할 수 있습니다.

1.9. RHEL 컴퓨팅 시스템을 포함하는 클러스터 업데이트

RHEL 컴퓨팅 머신이 포함된 클러스터 업데이트: 클러스터에 RHEL (Red Hat Enterprise Linux) 시스템이 포함된 경우 해당 머신을 업데이트하려면 추가 단계를 수행해야 합니다. 다음 절차를 수행할 수 있습니다.

1.10. 연결이 끊긴 환경에서 클러스터 업데이트

연결이 끊긴 환경의 클러스터 업데이트 정보: 미러 호스트가 인터넷과 클러스터에 모두 액세스할 수 없는 경우 해당 환경에서 연결이 끊긴 파일 시스템에 이미지를 미러링할 수 있습니다. 그런 다음 해당 호스트 또는 이동식 미디어를 가져올 수 있습니다. 로컬 컨테이너 레지스트리와 클러스터가 레지스트리의 미러 호스트에 연결된 경우 릴리스 이미지를 로컬 레지스트리로 직접 푸시할 수 있습니다.

- 미러 호스트 준비

- 이미지를 미러링할 수 있는 인증 정보 설정

- OpenShift Container Platform 이미지 저장소 미러링

- 연결이 끊긴 클러스터 업데이트

- 이미지 레지스트리 저장소 미러링 설정

- 클러스터 노드 재부팅 빈도를 줄이기 위해 미러 이미지 카탈로그의 범위 확장

- OpenShift Update Service Operator 설치

- OpenShift Update Service 애플리케이션 생성

- OpenShift Update Service 애플리케이션 삭제

- OpenShift Update Service Operator 설치 제거

1.11. vSphere에서 실행되는 노드에서 하드웨어 업데이트

vSphere에서 하드웨어 업데이트: vSphere 에서 실행 중인 노드가 OpenShift Container Platform에서 지원하는 하드웨어 버전에서 실행 중인지 확인해야 합니다. 현재 클러스터의 vSphere 가상 머신에서 하드웨어 버전 15 이상이 지원됩니다. 자세한 내용은 다음을 참조하십시오.

OpenShift Container Platform 버전 4.12에는 VMware 가상 하드웨어 버전 15 이상이 필요합니다.

2장. OpenShift 업데이트 이해

2.1. OpenShift 업데이트 소개

OpenShift Container Platform 4에서는 웹 콘솔 또는 OpenShift CLI(oc)를 사용하여 단일 작업으로 OpenShift Container Platform 클러스터를 업데이트할 수 있습니다. 플랫폼 관리자는 웹 콘솔에서 관리 → 클러스터 설정으로 이동하거나 oc adm upgrade 명령의 출력을 확인하여 새 업데이트 옵션을 볼 수 있습니다.

Red Hat은 공식 레지스트리의 OpenShift Container Platform 릴리스 이미지를 기반으로 하는 업데이트 가능성 그래프를 제공하는 OSUS(OpenShift Update Service)를 호스팅합니다. 그래프에는 모든 공용 OCP 릴리스에 대한 업데이트 정보가 포함되어 있습니다. OpenShift Container Platform 클러스터는 기본적으로 OSUS에 연결하도록 구성되며 OSUS는 알려진 업데이트 대상에 대한 정보를 사용하여 클러스터에 응답합니다.

클러스터 관리자 또는 자동 업데이트 컨트롤러가 새 버전으로 CVO(Cluster Version Operator)의 CR(사용자 정의 리소스)을 편집할 때 업데이트가 시작됩니다. 새로 지정된 버전으로 클러스터를 조정하기 위해 CVO는 이미지 레지스트리에서 대상 릴리스 이미지를 검색하고 변경 사항을 클러스터에 적용하기 시작합니다.

OLM(Operator Lifecycle Manager)을 통해 이전에 설치한 Operator는 업데이트를 위해 다른 프로세스를 따릅니다. 자세한 내용은 설치된 Operator 업데이트를 참조하십시오.

대상 릴리스 이미지에는 특정 OCP 버전을 구성하는 모든 클러스터 구성 요소에 대한 매니페스트 파일이 포함되어 있습니다. 클러스터를 새 버전으로 업데이트할 때 CVO는 Runlevels라는 별도의 단계에 매니페스트를 적용합니다. 대부분은 아니지만 일부 매니페스트는 클러스터 Operator 중 하나를 지원합니다. CVO는 클러스터 Operator에 매니페스트를 적용하므로 Operator에서 업데이트 작업을 수행하여 새 지정된 버전으로 조정할 수 있습니다.

CVO는 적용되는 각 리소스의 상태 및 모든 클러스터 Operator가 보고한 상태를 모니터링합니다. CVO는 활성 Runlevel의 모든 매니페스트 및 클러스터 Operator가 안정적인 상태에 도달하는 경우에만 업데이트를 진행합니다. CVO는 이 프로세스를 통해 전체 컨트롤 플레인을 업데이트한 후 MCO(Machine Config Operator)는 클러스터의 모든 노드의 운영 체제 및 구성을 업데이트합니다.

2.1.1. 업데이트 가용성에 대한 일반적인 질문

OpenShift Container Platform 클러스터에서 업데이트를 사용할 수 있는 경우 및 경우에 영향을 미치는 몇 가지 요소가 있습니다. 다음 목록은 업데이트 가용성에 대한 일반적인 질문을 제공합니다.

각 업데이트 채널의 차이점은 무엇입니까?

-

처음에 새 릴리스가

candidate채널에 추가됩니다. -

최종 테스트를 완료한 후

candidate채널의 릴리스가fast채널로 승격되고 에라타가 게시되고 릴리스가 완전히 지원됩니다. 지연 후

fast채널의 릴리스는 결국stable채널로 승격됩니다. 이 지연은fast채널과stable채널의 유일한 차이점입니다.참고최신 z-stream 릴리스의 경우 이 지연은 일반적으로 1주 또는 2주가 될 수 있습니다. 그러나 최신 마이너 버전에 대한 초기 업데이트 지연은 일반적으로 45-90일로 더 오래 걸릴 수 있습니다.

-

stable채널로 승격된 릴리스는 동시에eus채널로 확장됩니다.eus채널의 주요 목적은 EUS-to-EUS 업데이트를 수행하는 클러스터의 편의를 제공하는 것입니다.

stable 채널의 릴리스가 fast 채널의 릴리스보다 안전하거나 더 지원됩니까?

-

fast채널의 릴리스에 대해 회귀 문제가 확인되면stable채널의 릴리스에 대해 해당 회귀가 식별된 경우와 동일한 범위로 확인되고 관리됩니다. -

fast및stable채널에서 릴리스의 유일한 차이점은 릴리스가 잠시 동안fast채널에 있는 후에만stable채널에 표시되므로 새로운 업데이트 위험을 더 많이 사용할 수 있다는 것입니다. -

fast채널에서 사용 가능한 릴리스는 이 지연 후stable채널에서 항상 사용할 수 있습니다.

업데이트가 지원되지만 권장되지 않는 경우 무엇을 의미합니까?

- Red Hat은 여러 소스의 데이터를 지속적으로 평가하여 한 버전에서 다른 버전으로의 업데이트가 문제가 발생하는지 확인합니다. 문제가 확인된 경우 업데이트 경로가 더 이상 사용자에게 권장되지 않을 수 있습니다. 그러나 업데이트 경로가 권장되지 않더라도 업데이트를 수행하는 경우에도 고객은 계속 지원됩니다.

Red Hat은 사용자가 특정 버전으로의 업데이트를 차단하지 않습니다. Red Hat은 특정 클러스터에 적용되거나 적용되지 않을 수 있는 조건부 업데이트 위험을 선언할 수 있습니다.

- 선언된 위험은 클러스터 관리자에게 지원되는 업데이트에 대한 자세한 컨텍스트를 제공합니다. 클러스터 관리자는 특정 대상 버전으로의 위험 및 업데이트를 계속 허용할 수 있습니다. 이 업데이트는 조건부 위험 컨텍스트에서 권장되지 않더라도 항상 지원됩니다.

특정 릴리스에 대한 업데이트가 더 이상 권장되지 않는 경우 어떻게 해야 합니까?

- 문제 해결으로 인해 Red Hat이 지원되는 릴리스에서 업데이트 권장 사항을 제거하는 경우 회귀 문제를 수정하는 향후 버전에 후속 업데이트 권장 사항이 제공됩니다. 결함이 수정, 테스트 및 선택한 채널로 승격되는 동안 지연이 발생할 수 있습니다.

다음 z-stream 릴리스를 빠르고 안정적인 채널에서 사용할 수 있는 기간은 얼마나 됩니까?

특정 주기는 여러 요인에 따라 다를 수 있지만 최신 마이너 버전의 새로운 z-stream 릴리스는 일반적으로 매주 사용할 수 있습니다. 시간이 지남에 따라 더 안정적인 이전 마이너 버전은 새로운 z-stream 릴리스를 사용할 수 있도록 하는 데 시간이 오래 걸릴 수 있습니다.

중요이는 z-stream 릴리스에 대한 이전 데이터를 기반으로 하는 추정치일 뿐입니다. Red Hat은 필요에 따라 릴리스 빈도를 변경할 수 있는 권한을 갖습니다. 모든 문제는 이 릴리스 주기에서 불규칙성 및 지연을 유발할 수 있습니다.

-

z-stream 릴리스가 게시되면 해당 마이너 버전의

fast채널에도 표시됩니다. 지연 후 z-stream 릴리스는 해당 마이너 버전의stable채널에 표시될 수 있습니다.

추가 리소스

2.1.2. OpenShift 업데이트 서비스 정보

OSUS(OpenShift Update Service)는 RHCOS(Red Hat Enterprise Linux CoreOS)를 포함하여 OpenShift Container Platform에 대한 업데이트 권장 사항을 제공합니다. 구성 요소 Operator의 정점과 이를 연결하는 에지를 포함하는 그래프 또는 다이어그램을 제공합니다. 그래프의 에지에는 안전하게 업데이트할 수 있는 버전이 표시됩니다. 정점은 관리형 클러스터 구성 요소의 상태를 지정하는 업데이트 페이로드입니다.

클러스터의 CVO (Cluster Version Operator)는 OpenShift Update Service를 확인하여 현재 구성 요소 버전 및 그래프의 정보를 기반으로 유효한 업데이트 및 업데이트 경로를 확인합니다. 업데이트를 요청하면 CVO는 해당 릴리스 이미지를 사용하여 클러스터를 업데이트합니다. 릴리스 아티팩트는 Quay에서 컨테이너 이미지로 호스팅됩니다.

OpenShift Update Service가 호환 가능한 업데이트만 제공할 수 있도록 자동화를 지원하는 버전 확인 파이프 라인이 제공됩니다. 각 릴리스 아티팩트는 지원되는 클라우드 플랫폼 및 시스템 아키텍처 및 기타 구성 요소 패키지와의 호환성 여부를 확인합니다. 파이프 라인에서 적용 가능한 버전이 있음을 확인한 후 OpenShift Update Service는 해당 버전 업데이트를 사용할 수 있음을 알려줍니다.

OpenShift Update Service는 현재 클러스터에 권장되는 모든 업데이트를 표시합니다. OpenShift Update Service에서 업데이트 경로를 권장하지 않는 경우 업데이트 또는 대상 릴리스에서 알려진 문제 때문일 수 있습니다.

연속 업데이트 모드에서는 두 개의 컨트롤러가 실행됩니다. 하나의 컨트롤러는 페이로드 매니페스트를 지속적으로 업데이트하여 매니페스트를 클러스터에 적용한 다음 Operator의 제어된 롤아웃 상태를 출력하여 사용 가능한지, 업그레이드했는지 또는 실패했는지의 여부를 나타냅니다. 두 번째 컨트롤러는 OpenShift Update Service를 폴링하여 업데이트를 사용할 수 있는지 확인합니다.

최신 버전으로만 업데이트할 수 있습니다. 클러스터를 이전 버전으로 되돌리거나 롤백을 수행하는 것은 지원되지 않습니다. 업데이트에 실패하면 Red Hat 지원팀에 문의하십시오.

업데이트 프로세스 중에 MCO(Machine Config Operator)는 새 구성을 클러스터 머신에 적용합니다. MCO는 머신 구성 풀의 maxUnavailable 필드에 지정된 노드 수를 제한하고 사용할 수 없음을 표시합니다. 기본적으로 이 값은 1로 설정됩니다. MCO는 topology.kubernetes.io/zone 레이블을 기반으로 영역별로 영향을 받는 노드를 사전순으로 업데이트합니다. 영역에 둘 이상의 노드가 있으면 가장 오래된 노드가 먼저 업데이트됩니다. 베어 메탈 배포에서와 같이 영역을 사용하지 않는 노드의 경우 노드가 수명에 따라 업데이트되며 가장 오래된 노드가 먼저 업데이트됩니다. MCO는 한 번에 머신 구성 풀의 maxUnavailable 필드에 지정된 노드 수를 업데이트합니다. MCO는 새 설정을 적용하여 컴퓨터를 다시 시작합니다.

RHEL (Red Hat Enterprise Linux) 머신을 작업자로 사용하는 경우 먼저 시스템에서 OpenShift API를 업데이트해야하기 때문에 MCO는 이 머신에서 kubelet을 업데이트하지 않습니다.

새 버전의 사양이 이전 kubelet에 적용되므로 RHEL 머신을 Ready 상태로 되돌릴 수 없습니다. 컴퓨터를 사용할 수 있을 때까지 업데이트를 완료할 수 없습니다. 그러나 사용 불가능한 최대 노드 수를 설정하면 사용할 수 없는 머신의 수가 이 값을 초과하지 않는 경우에도 정상적인 클러스터 작업을 계속할 수 있습니다.

OpenShift Update Service는 Operator 및 하나 이상의 애플리케이션 인스턴스로 구성됩니다.

2.1.3. 일반 용어

- 컨트롤 플레인

- 컨트롤 플레인 머신으로 구성된 컨트롤 플레인 는 OpenShift Container Platform 클러스터를 관리합니다. 컨트롤 플레인 머신에서는 작업자 머신이라고도 하는 컴퓨팅 머신의 워크로드를 관리합니다.

- Cluster Version Operator

- CVO( Cluster Version Operator )는 클러스터의 업데이트 프로세스를 시작합니다. 현재 클러스터 버전을 기반으로 OSUS를 확인하고 사용 가능한 업데이트 경로가 포함된 그래프를 검색합니다.

- Machine Config Operator

- MCO( Machine Config Operator )는 운영 체제 및 머신 구성을 관리하는 클러스터 수준 Operator입니다. MCO를 통해 플랫폼 관리자는 작업자 노드에서 systemd, CRI-O 및 Kubelet, kernel, NetworkManager 및 기타 시스템 기능을 구성하고 업데이트할 수 있습니다.

- OpenShift 업데이트 서비스

- OSUS( OpenShift Update Service )는 RHCOS(Red Hat Enterprise Linux CoreOS)를 포함하여 OpenShift Container Platform에 대한 무선 업데이트를 제공합니다. 구성 요소 Operator의 정점과 이를 연결하는 에지를 포함하는 그래프 또는 다이어그램을 제공합니다.

- 채널

- 채널은 OpenShift Container Platform의 마이너 버전과 연결된 업데이트 전략을 선언합니다. OSUS는 이 구성된 전략을 사용하여 해당 전략과 일치하는 에지를 업데이트할 것을 권장합니다.

- 권장되는 업데이트 에지

- 권장 업데이트 에지 는 OpenShift Container Platform 릴리스 간에 권장되는 업데이트입니다. 지정된 업데이트가 클러스터의 구성된 채널, 현재 버전, 알려진 버그 및 기타 정보에 따라 달라질 수 있는지 여부입니다. OSUS는 권장되는 에지를 모든 클러스터에서 실행되는 CVO와 통신합니다.

- EUS (Extended Update Support)

모든 post-4.7 짝수의 마이너 릴리스는 EUS ( Extended Update Support ) 릴리스로 지정됩니다. 이러한 릴리스에서는 EUS 릴리스 간에 검증된 업데이트 경로를 도입하여 작업자 노드의 업데이트를 간소화하고 EUS에서 EUS에서 OpenShift Container Platform 릴리스의 업데이트 전략을 공식화하여 작업자 노드의 재부팅 횟수를 줄일 수 있습니다.

자세한 내용은 Red Hat OpenShift Extended Update Support (EUS) 개요 를 참조하십시오.

2.1.4. 추가 리소스

- 업데이트 프로세스의 각 주요 측면에 대한 자세한 내용은 클러스터 업데이트 작동 방법을 참조하십시오.

2.2. 클러스터 업데이트 작동 방식

다음 섹션에서는 OCP(OpenShift Container Platform) 업데이트 프로세스의 각 주요 측면을 자세히 설명합니다. 업데이트가 작동하는 방법에 대한 일반적인 개요는 OpenShift 업데이트 소개를 참조하십시오.

2.2.1. Cluster Version Operator

CVO(Cluster Version Operator)는 OpenShift Container Platform 업데이트 프로세스를 오케스트레이션하고 용이하게 하는 주요 구성 요소입니다. 설치 및 표준 클러스터 작업 중에 CVO는 관리 클러스터 Operator의 매니페스트를 클러스터 내부 리소스와 지속적으로 비교하고 불일치를 조정하여 이러한 리소스의 실제 상태가 원하는 상태와 일치하는지 확인합니다.

2.2.1.1. ClusterVersion 오브젝트

CVO(Cluster Version Operator)에서 모니터링하는 리소스 중 하나는 ClusterVersion 리소스입니다.

관리자 및 OpenShift 구성 요소는 ClusterVersion 오브젝트를 통해 CVO와 통신하거나 상호 작용할 수 있습니다. 원하는 CVO 상태는 ClusterVersion 오브젝트를 통해 선언되며 현재 CVO 상태는 오브젝트 상태에 반영됩니다.

ClusterVersion 오브젝트를 직접 수정하지 마십시오. 대신 oc CLI 또는 웹 콘솔과 같은 인터페이스를 사용하여 업데이트 대상을 선언합니다.

CVO는 ClusterVersion 리소스의 spec 속성에 선언된 대상 상태로 클러스터를 지속적으로 조정합니다. 원하는 릴리스가 실제 릴리스와 다른 경우 조정이 클러스터를 업데이트합니다.

가용성 데이터 업데이트

ClusterVersion 리소스에는 클러스터에서 사용할 수 있는 업데이트에 대한 정보도 포함되어 있습니다. 여기에는 클러스터에 적용되는 알려진 위험으로 인해 사용할 수 있지만 권장되지 않는 업데이트가 포함됩니다. 이러한 업데이트를 조건부 업데이트라고 합니다. CVO가 ClusterVersion 리소스의 사용 가능한 업데이트에 대한 이 정보를 유지 관리하는 방법에 대한 자세한 내용은 "업데이트 가용성 평가" 섹션을 참조하십시오.

다음 명령을 사용하여 사용 가능한 모든 업데이트를 검사할 수 있습니다.

$ oc adm upgrade --include-not-recommended

참고추가

--include-not-recommended매개변수에는 클러스터에 적용되는 알려진 위험으로 인해 사용할 수 있지만 권장되지 않는 업데이트가 포함되어 있습니다.출력 예

Cluster version is 4.10.22 Upstream is unset, so the cluster will use an appropriate default. Channel: fast-4.11 (available channels: candidate-4.10, candidate-4.11, eus-4.10, fast-4.10, fast-4.11, stable-4.10) Recommended updates: VERSION IMAGE 4.10.26 quay.io/openshift-release-dev/ocp-release@sha256:e1fa1f513068082d97d78be643c369398b0e6820afab708d26acda2262940954 4.10.25 quay.io/openshift-release-dev/ocp-release@sha256:ed84fb3fbe026b3bbb4a2637ddd874452ac49c6ead1e15675f257e28664879cc 4.10.24 quay.io/openshift-release-dev/ocp-release@sha256:aab51636460b5a9757b736a29bc92ada6e6e6282e46b06e6fd483063d590d62a 4.10.23 quay.io/openshift-release-dev/ocp-release@sha256:e40e49d722cb36a95fa1c03002942b967ccbd7d68de10e003f0baa69abad457b Supported but not recommended updates: Version: 4.11.0 Image: quay.io/openshift-release-dev/ocp-release@sha256:300bce8246cf880e792e106607925de0a404484637627edf5f517375517d54a4 Recommended: False Reason: RPMOSTreeTimeout Message: Nodes with substantial numbers of containers and CPU contention may not reconcile machine configuration https://bugzilla.redhat.com/show_bug.cgi?id=2111817#c22

oc adm upgrade명령은ClusterVersion리소스에 사용 가능한 업데이트에 대한 정보를 쿼리하고 사용자가 읽을 수 있는 형식으로 제공합니다.CVO에서 생성한 기본 가용성 데이터를 직접 검사하는 한 가지 방법은 다음 명령을 사용하여

ClusterVersion리소스를 쿼리하는 것입니다.$ oc get clusterversion version -o json | jq '.status.availableUpdates'

출력 예

[ { "channels": [ "candidate-4.11", "candidate-4.12", "fast-4.11", "fast-4.12" ], "image": "quay.io/openshift-release-dev/ocp-release@sha256:400267c7f4e61c6bfa0a59571467e8bd85c9188e442cbd820cc8263809be3775", "url": "https://access.redhat.com/errata/RHBA-2023:3213", "version": "4.11.41" }, ... ]유사한 명령을 사용하여 조건부 업데이트를 확인할 수 있습니다.

$ oc get clusterversion version -o json | jq '.status.conditionalUpdates'

출력 예

[ { "conditions": [ { "lastTransitionTime": "2023-05-30T16:28:59Z", "message": "The 4.11.36 release only resolves an installation issue https://issues.redhat.com//browse/OCPBUGS-11663 , which does not affect already running clusters. 4.11.36 does not include fixes delivered in recent 4.11.z releases and therefore upgrading from these versions would cause fixed bugs to reappear. Red Hat does not recommend upgrading clusters to 4.11.36 version for this reason. https://access.redhat.com/solutions/7007136", "reason": "PatchesOlderRelease", "status": "False", "type": "Recommended" } ], "release": { "channels": [...], "image": "quay.io/openshift-release-dev/ocp-release@sha256:8c04176b771a62abd801fcda3e952633566c8b5ff177b93592e8e8d2d1f8471d", "url": "https://access.redhat.com/errata/RHBA-2023:1733", "version": "4.11.36" }, "risks": [...] }, ... ]

2.2.1.2. 업데이트 가용성 평가

CVO(Cluster Version Operator)는 업데이트 가능성에 대한 최신 데이터에 대해 OSUS(OpenShift Update Service)를 주기적으로 쿼리합니다. 이 데이터는 클러스터의 서브스크립션 채널을 기반으로 합니다. 그런 다음 CVO는 업데이트 권장 사항에 대한 정보를 ClusterVersion 리소스의 availableUpdates 또는 conditionalUpdates 필드에 저장합니다.

CVO는 조건부 업데이트에서 업데이트 위험을 주기적으로 확인합니다. 이러한 위험은 OSUS에서 제공하는 데이터를 통해 전달되며, 여기에는 해당 버전으로 업데이트된 클러스터에 영향을 미칠 수 있는 알려진 문제에 대한 각 버전에 대한 정보가 포함되어 있습니다. 대부분의 위험은 특정 클라우드 플랫폼에 배포된 특정 크기 또는 클러스터가 있는 클러스터와 같이 특정 특성이 있는 클러스터로 제한됩니다.

CVO는 각 조건부 업데이트의 조건부 위험 정보에 대해 클러스터 특성을 지속적으로 평가합니다. CVO가 클러스터가 기준과 일치하도록 발견하면 CVO는 이 정보를 ClusterVersion 리소스의 conditionalUpdates 필드에 저장합니다. CVO가 클러스터가 업데이트 위험과 일치하지 않거나 업데이트와 관련된 위험이 없는 경우 ClusterVersion 리소스의 availableUpdates 필드에 대상 버전을 저장합니다.

사용자 인터페이스(웹 콘솔 또는 OpenShift CLI(oc))는 이 정보를 관리자에게 제목으로 지정합니다. 지원되지만 권장 업데이트 권장 사항은 관리자가 업데이트에 대해 정보에 입각한 결정을 내릴 수 있도록 위험 관련 추가 리소스에 대한 링크가 포함되어 있습니다.

추가 리소스

2.2.2. 이미지 릴리스

릴리스 이미지는 특정 OCP(OpenShift Container Platform) 버전에 대한 제공 메커니즘입니다. 릴리스 메타데이터, 릴리스 버전과 일치하는 CVO(Cluster Version Operator) 바이너리, 개별 OpenShift 클러스터 Operator를 배포하는 데 필요한 모든 매니페스트 및 이 OpenShift 버전을 구성하는 모든 컨테이너 이미지에 대한 SHA 다이제스트 버전 참조 목록이 포함되어 있습니다.

다음 명령을 실행하여 특정 릴리스 이미지의 콘텐츠를 검사할 수 있습니다.

$ oc adm release extract <release image>

출력 예

$ oc adm release extract quay.io/openshift-release-dev/ocp-release:4.12.6-x86_64 Extracted release payload from digest sha256:800d1e39d145664975a3bb7cbc6e674fbf78e3c45b5dde9ff2c5a11a8690c87b created at 2023-03-01T12:46:29Z $ ls 0000_03_authorization-openshift_01_rolebindingrestriction.crd.yaml 0000_03_config-operator_01_proxy.crd.yaml 0000_03_marketplace-operator_01_operatorhub.crd.yaml 0000_03_marketplace-operator_02_operatorhub.cr.yaml 0000_03_quota-openshift_01_clusterresourcequota.crd.yaml 1 ... 0000_90_service-ca-operator_02_prometheusrolebinding.yaml 2 0000_90_service-ca-operator_03_servicemonitor.yaml 0000_99_machine-api-operator_00_tombstones.yaml image-references 3 release-metadata

2.2.3. 프로세스 워크플로 업데이트

다음 단계는 OCP(OpenShift Container Platform) 업데이트 프로세스의 자세한 워크플로를 나타냅니다.

-

대상 버전은 웹 콘솔 또는 CLI를 통해 관리할 수 있는

ClusterVersion리소스의spec.desiredUpdate.version필드에 저장됩니다. -

CVO(Cluster Version Operator)는

ClusterVersion리소스의desiredUpdate가 현재 클러스터 버전과 다른 것을 감지합니다. OpenShift Update Service의 그래프 데이터를 사용하여 CVO는 원하는 클러스터 버전을 릴리스 이미지의 가져오기 사양으로 확인합니다. - CVO는 릴리스 이미지의 무결성 및 진위 여부를 검증합니다. Red Hat은 이미지 SHA 다이제스트를 고유하고 변경할 수 없는 릴리스 이미지 식별자로 사용하여 사전 정의된 위치에서 게시된 릴리스 이미지에 대해 암호화 방식으로 서명합니다. CVO는 기본 제공 공개 키 목록을 사용하여 선택한 릴리스 이미지와 일치하는 문의 존재 및 서명을 검증합니다.

-

CVO는

openshift-cluster-version네임스페이스에version-$version-$hash라는 작업을 생성합니다. 이 작업은 릴리스 이미지를 실행하는 컨테이너를 사용하므로 클러스터는 컨테이너 런타임을 통해 이미지를 다운로드합니다. 그런 다음 이 작업은 릴리스 이미지의 매니페스트 및 메타데이터를 CVO에 액세스할 수 있는 공유 볼륨으로 추출합니다. - CVO는 추출된 매니페스트 및 메타데이터의 유효성을 검사합니다.

- CVO는 일부 사전 조건을 검사하여 클러스터에서 문제가 있는 상태가 탐지되지 않도록 합니다. 특정 조건은 업데이트가 진행되지 않도록 할 수 있습니다. 이러한 조건은 CVO 자체에 의해 결정되거나, Operator가 업데이트에 문제가 있다고 간주하는 클러스터에 대한 몇 가지 세부 정보를 감지하는 개별 클러스터 Operator에 의해 보고됩니다.

-

CVO는 허용되는 릴리스를

status.desired에 기록하고 새 업데이트에 대한status.history항목을 생성합니다. - CVO는 릴리스 이미지에서 매니페스트를 조정하기 시작합니다. 클러스터 Operator는 Runlevels라는 별도의 단계에서 업데이트되며 CVO는 다음 단계로 진행하기 전에 Runlevel 완료 업데이트의 모든 Operator를 확인합니다.

- CVO 자체에 대한 매니페스트는 프로세스 초기에 적용됩니다. CVO 배포가 적용되면 현재 CVO Pod가 중지되고 새 버전을 사용하는 CVO Pod가 시작됩니다. 새 CVO는 나머지 매니페스트를 조정합니다.

-

업데이트는 전체 컨트롤 플레인이 새 버전으로 업데이트될 때까지 진행됩니다. 개별 클러스터 Operator는 클러스터 도메인에서 업데이트 작업을 수행할 수 있으며 이렇게 하는 동안

Progressing=True조건을 통해 상태를 보고합니다. - MCO(Machine Config Operator) 매니페스트는 프로세스 종료에 적용됩니다. 그런 다음 업데이트된 MCO는 모든 노드의 시스템 구성 및 운영 체제를 업데이트하기 시작합니다. 워크로드를 다시 수락하기 전에 각 노드를 드레이닝, 업데이트 및 재부팅할 수 있습니다.

일반적으로 모든 노드가 업데이트되기 전에 클러스터는 컨트롤 플레인 업데이트가 완료된 후 업데이트된 것으로 보고합니다. 업데이트 후 CVO는 릴리스 이미지에서 전달된 상태와 일치하도록 모든 클러스터 리소스를 유지 관리합니다.

2.2.4. 업데이트 중에 매니페스트가 적용되는 방법 이해

릴리스 이미지에 제공된 일부 매니페스트는 둘 사이의 종속 항목으로 인해 특정 순서로 적용해야 합니다. 예를 들어 일치하는 사용자 지정 리소스보다 먼저 CustomResourceDefinition 리소스를 생성해야 합니다. 또한 클러스터 중단을 최소화하기 위해 개별 클러스터 Operator를 업데이트해야 하는 논리적 순서가 있습니다. CVO(Cluster Version Operator)는 Runlevels라는 개념을 통해 이 논리 순서를 구현합니다.

이러한 종속 항목은 릴리스 이미지에 있는 매니페스트의 파일 이름으로 인코딩됩니다.

0000_<runlevel>_<component>_<manifest-name>.yaml

예를 들면 다음과 같습니다.

0000_03_config-operator_01_proxy.crd.yaml

CVO는 내부적으로 매니페스트에 대한 종속성 그래프를 빌드하며 CVO는 다음 규칙을 따릅니다.

- 업데이트 중에 더 낮은 Runlevel의 매니페스트가 더 높은 Runlevel의 매니페스트보다 먼저 적용됩니다.

- 하나의 Runlevel 내에서 다른 구성 요소에 대한 매니페스트를 병렬로 적용할 수 있습니다.

- 하나의 Runlevel 내에서 단일 구성 요소에 대한 매니페스트가 사전순으로 적용됩니다.

CVO는 생성된 종속성 그래프 다음에 매니페스트를 적용합니다.

일부 리소스 유형의 경우 CVO는 매니페스트가 적용된 후 리소스를 모니터링하고 리소스가 stable 상태에 도달한 후에만 성공적으로 업데이트되도록 간주합니다. 이 상태를 달성하는 데는 약간의 시간이 걸릴 수 있습니다. 이는 ClusterOperator 리소스에 특히 해당되며 CVO는 클러스터 Operator가 자체적으로 업데이트되고 ClusterOperator 상태를 업데이트할 때까지 대기합니다.

CVO는 Runlevel의 모든 클러스터 Operator가 다음 Runlevel으로 진행하기 전에 다음 조건을 충족할 때까지 기다립니다.

-

클러스터 Operator에는

Available=True조건이 있습니다. -

클러스터 Operator에는

Degraded=False조건이 있습니다.

- 클러스터 Operator는 ClusterOperator 리소스에서 원하는 버전을 달성했다고 선언합니다.

일부 작업은 완료하는 데 상당한 시간이 걸릴 수 있습니다. CVO는 후속 Runlevels가 안전하게 진행할 수 있도록 작업이 완료될 때까지 기다립니다. 처음에는 새 릴리스의 매니페스트를 조정하는 데 총 60~120분이 걸릴 것으로 예상됩니다. 업데이트 기간에 영향을 미치는 요인에 대한 자세한 내용은 OpenShift Container Platform 업데이트 기간 이해 를 참조하십시오.

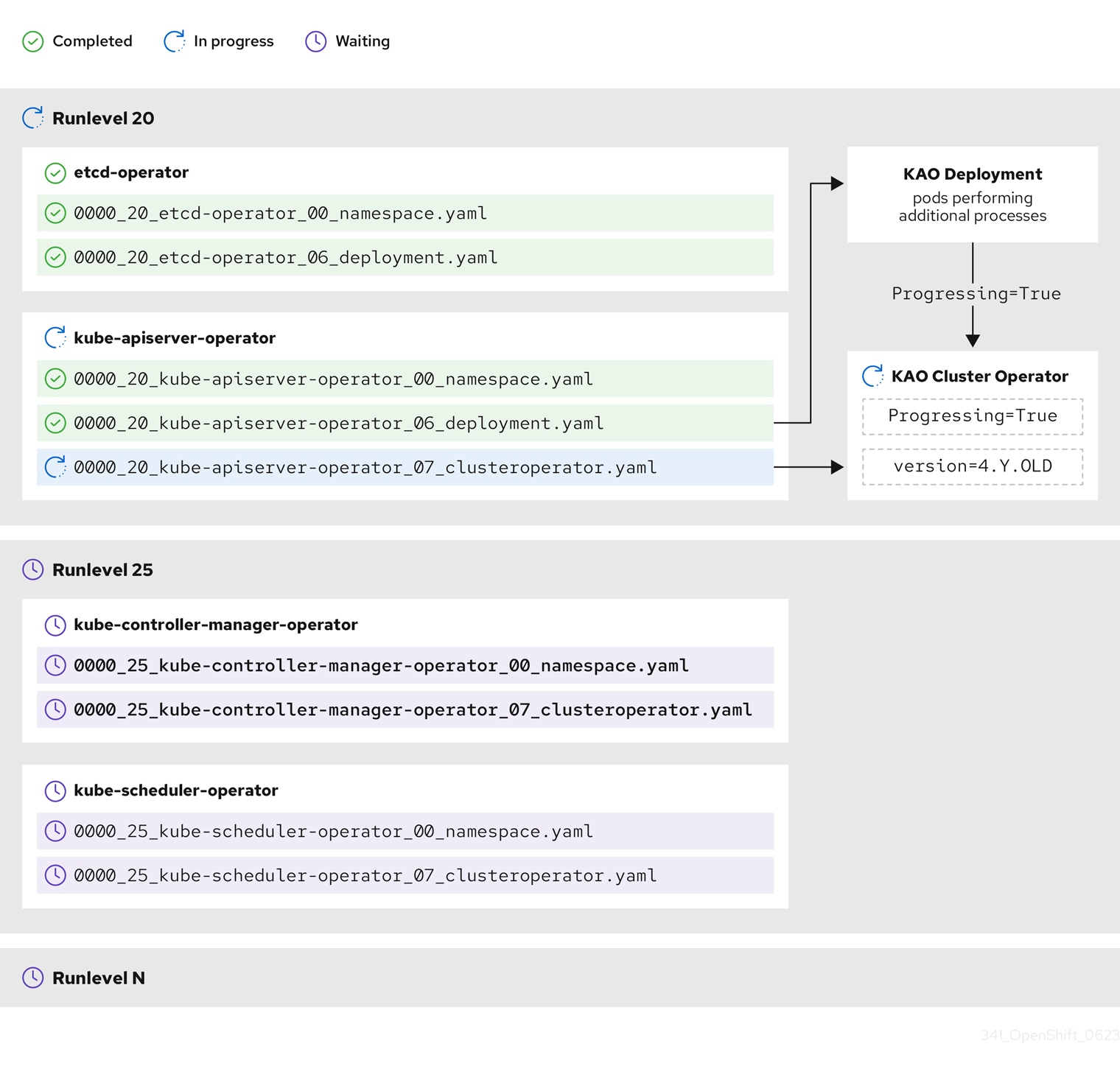

이전 예제 다이어그램에서 CVO는 Runlevel 20에서 모든 작업이 완료될 때까지 대기 중입니다. CVO는 Runlevel의 Operator에 모든 매니페스트를 적용했지만 kube-apiserver-operator ClusterOperator 는 새 버전이 배포된 후 일부 작업을 수행합니다. kube-apiserver-operator ClusterOperator 는 Progressing=True 조건을 통해 이 진행 상황을 선언하고 새 버전을 status.versions 에서 reconciled로 선언하지 않습니다. CVO는 ClusterOperator가 허용 가능한 상태를 보고할 때까지 기다린 다음 Runlevel 25에서 매니페스트를 조정하기 시작합니다.

2.2.5. Machine Config Operator가 노드를 업데이트하는 방법 이해

MCO(Machine Config Operator)는 각 컨트롤 플레인 노드 및 컴퓨팅 노드에 새 머신 구성을 적용합니다. 머신 구성 업데이트 중에 컨트롤 플레인 노드와 컴퓨팅 노드는 머신 풀이 병렬로 업데이트되는 자체 머신 구성 풀로 구성됩니다. 기본 값이 1 인 .spec.maxUnavailable 매개변수는 머신 구성 풀의 노드 수를 동시에 수행할 수 있는 업데이트 프로세스를 결정합니다.

머신 구성 업데이트 프로세스가 시작되면 MCO는 풀에서 현재 사용할 수 없는 노드의 양을 확인합니다. .spec.maxUnavailable 의 값보다 적은 노드가 있는 경우 MCO는 풀에서 사용 가능한 노드에서 다음 작업 시퀀스를 시작합니다.

노드를 차단하고 드레이닝

참고노드가 차단되면 워크로드를 예약할 수 없습니다.

- 노드의 시스템 구성 및 운영 체제(OS) 업데이트

- 노드 재부팅

- 노드 차단 해제

이 프로세스를 수행하는 노드는 차단 해제되고 워크로드를 다시 예약할 수 없을 때까지 사용할 수 없습니다. MCO는 사용할 수 없는 노드 수가 .spec.maxUnavailable 과 동일할 때까지 노드 업데이트를 시작합니다.

노드가 업데이트를 완료하고 사용 가능하게 되면 머신 구성 풀에서 사용할 수 없는 노드 수가 다시 한 번 .spec.maxUnavailable 보다 적습니다. 업데이트해야 하는 노드가 남아 있는 경우 MCO는 .spec.maxUnavailable 제한에 다시 도달할 때까지 노드에서 업데이트 프로세스를 시작합니다. 이 프로세스는 각 컨트롤 플레인 노드와 컴퓨팅 노드가 업데이트될 때까지 반복됩니다.

다음 예제 워크플로우에서는 5개의 노드가 있는 머신 구성 풀에서 이 프로세스가 발생하는 방법을 설명합니다. 여기서 .spec.maxUnavailable 은 3이고 모든 노드를 처음 사용할 수 있습니다.

- MCO는 1, 2, 3 노드를 차단하고 드레이닝하기 시작합니다.

- 노드 2 드레이닝, 재부팅 및 다시 사용할 수 있게 됩니다. MCO는 노드 4를 차단하고 드레이닝을 시작합니다.

- 노드 1이 드레이닝, 재부팅 및 다시 사용할 수 있게 됩니다. MCO 노드 5를 차단하고 드레이닝을 시작합니다.

- 노드 3은 드레이닝을 완료, 재부팅, 다시 사용할 수 있게 됩니다.

- 노드 5 드레이닝, 재부팅 및 다시 사용할 수 있게 됩니다.

- 노드 4 드레이닝, 재부팅 및 다시 사용할 수 있게 됩니다.

각 노드의 업데이트 프로세스는 다른 노드와 독립적이므로 위 예제의 일부 노드는 MCO에 의해 차단된 순서대로 업데이트를 완료합니다.

다음 명령을 실행하여 머신 구성 업데이트의 상태를 확인할 수 있습니다.

$ oc get mcp

출력 예

NAME CONFIG UPDATED UPDATING DEGRADED MACHINECOUNT READYMACHINECOUNT UPDATEDMACHINECOUNT DEGRADEDMACHINECOUNT AGE master rendered-master-acd1358917e9f98cbdb599aea622d78b True False False 3 3 3 0 22h worker rendered-worker-1d871ac76e1951d32b2fe92369879826 False True False 2 1 1 0 22h

추가 리소스

3장. 업데이트 채널 및 릴리스 이해

업데이트 채널은 클러스터를 업데이트하려는 OpenShift Container Platform 마이너 버전을 사용자가 선언하는 메커니즘입니다. 또한 사용자는 빠른,안정적인,후보 및 eus 채널 옵션을 통해 가질 업데이트의 타이밍과 수준을 선택할 수 있습니다. Cluster Version Operator는 다른 조건 정보와 함께 채널 선언을 기반으로 업데이트 그래프를 사용하여 클러스터에 사용 가능한 권장 및 조건부 업데이트 목록을 제공합니다.

업데이트 채널은 OpenShift Container Platform의 마이너 버전에 해당합니다. 채널의 버전 번호는 클러스터의 현재 마이너 버전보다 큰 경우에도 클러스터가 최종적으로 업데이트될 대상 마이너 버전을 나타냅니다.

예를 들어 OpenShift Container Platform 4.10 업데이트 채널은 다음과 같은 권장 사항을 제공합니다.

- 4.10 내에서 업데이트합니다.

- 4.9에서 업데이트

- 4.9에서 4.10으로 업데이트하여 모든 4.9 클러스터에서 최소 z-stream 버전 요구 사항을 즉시 충족하지 않는 경우에도 4.10으로 업데이트할 수 있습니다.

-

EUS-4.10만 해당: 4.8 내의 업데이트입니다. -

EUS-4.10만 해당: 4.8에서 4.9로 업데이트되어 모든 4.8 클러스터를 4.10으로 업데이트할 수 있습니다.

4.10 업데이트 채널은 4.11 이상 릴리스의 업데이트를 권장하지 않습니다. 이 전략을 사용하면 관리자가 OpenShift Container Platform의 다음 마이너 버전으로 업데이트할 것을 명시적으로 결정해야 합니다.

업데이트 채널은 릴리스 선택만 제어하고 설치하는 클러스터의 버전에 영향을 미치지 않습니다. 특정 버전의 OpenShift Container Platform에 대한 openshift-install 바이너리 파일은 항상 해당 버전을 설치합니다.

OpenShift Container Platform 4.12는 다음과 같은 업데이트 채널을 제공합니다.

-

stable-4.12 -

EUS-4.y(EUS 버전에만 제공되며 EUS 버전 간의 업데이트를 용이하게 함) -

fast-4.12 -

candidate-4.12

Cluster Version Operator가 업데이트 권장 사항 서비스에서 사용 가능한 업데이트를 가져오지 않도록 하려면 OpenShift CLI에서 oc adm upgrade channel 명령을 사용하여 빈 채널을 구성할 수 있습니다. 예를 들어 클러스터에서 네트워크 액세스가 제한되어 있고 로컬에 연결할 수 있는 업데이트 권장 사항이 없는 경우 이 구성이 유용할 수 있습니다.

Red Hat은 OpenShift Update Service에서 제안한 버전으로만 업데이트할 것을 권장합니다. 마이너 버전 업데이트의 경우 버전을 연속해야 합니다. Red Hat은 중요하지 않은 버전의 업데이트를 테스트하지 않으며 이전 버전과의 호환성을 보장할 수 없습니다.

3.1. 업데이트 채널

3.1.1. fast-4.12 채널

Red Hat이 버전을 GA(GA) 릴리스로 선언하면 fast-4.12 채널이 OpenShift Container Platform 4.12의 새 버전으로 업데이트됩니다. 따라서 이러한 릴리스는 완전히 지원되며 프로덕션 환경에서 사용하도록 설계되었습니다.

3.1.2. stable-4.12 채널

에라타가 출시되면 곧 fast-4.12 채널에 표시되지만 릴리스는 지연 후 stable-4.12 채널에 추가됩니다. 이러한 지연 기간 동안 데이터는 여러 소스에서 수집되어 제품 회귀 표시를 위해 분석됩니다. 상당한 수의 데이터 포인트가 수집되면 이러한 릴리스가 stable 채널에 추가됩니다.

많은 수의 데이터 포인트를 얻는 데 필요한 시간은 여러 요인에 따라 다르기 때문에 빠르고 안정적인 채널 간의 지연 기간 동안 SLO (Service LeveL Objective)가 제공되지 않습니다. 자세한 내용은 "클러스터에 올바른 채널 구성"을 참조하십시오.

새로 설치된 클러스터는 기본적으로 stable 채널을 사용합니다.

3.1.3. EUS-4.y 채널

stable 채널 외에도 OpenShift Container Platform의 모든 짝수의 마이너 버전은 EUS ( Extended Update Support )를 제공합니다. stable 채널로 승격된 릴리스도 EUS 채널로 동시에 승격됩니다. EUS 채널의 주요 목적은 EUS-to-EUS 업데이트를 수행하는 클러스터의 편의를 제공하는 것입니다.

표준 및 비EUS 구독자는 모두 모든 EUS 리포지토리에 액세스할 수 있으며 필요한 RPM(rhel-*-eus-rpms)은 디버깅 및 빌드 드라이버와 같은 중요한 목적을 지원할 수 있습니다.

3.1.4. candidate-4.12 채널

candidate-4.12 채널은 구축된 즉시 릴리스에 대한 조기 액세스 권한을 제공합니다. 후보 채널에만 있는 릴리스에는 최종 GA 릴리스의 전체 기능 세트가 포함되어 있지 않거나 GA 이전에 제거될 수 있습니다. 또한 이러한 릴리스는 Red Hat Quality Assurance의 적용을 받지 않았으며 이후 GA 릴리스에 대한 업데이트 경로를 제공하지 않을 수 있습니다. 이러한 주의 사항을 고려할 때 후보 채널은 클러스터를 삭제하고 다시 생성하는 것이 허용되는 테스트 목적에만 적합합니다.

3.1.5. 채널에서 권장 사항 업데이트

OpenShift Container Platform은 설치된 OpenShift Container Platform 버전과 채널 내에서 가져올 경로를 알고 있는 업데이트 권장 서비스를 유지 관리하여 다음 릴리스로 이동합니다. 업데이트 경로는 현재 선택한 채널 및 승격 특성과 관련된 버전으로 제한됩니다.

채널에서 다음 릴리스를 확인할 수 있습니다.

- 4.12.0

- 4.12.1

- 4.12.3

- 4.12.4

이 서비스는 테스트되어 심각한 회귀 문제가 없는 업데이트만 권장합니다. 예를 들어 클러스터가 4.12.1에 있고 OpenShift Container Platform에서 4.12.4를 권장하는 경우 4.12.1에서 4.12.4로 업데이트하는 것이 좋습니다.

연속적인 패치 번호에 의존하지 않도록하십시오. 이 예에서 4.12.2는 채널에서 사용 불가능합니다. 따라서 4.12.2 업데이트는 권장되지 않거나 지원되지 않습니다.

3.1.6. 업데이트 권장 사항 및 조건 업데이트

Red Hat은 새로 릴리스된 버전을 모니터링하고 해당 버전과 관련된 경로를 지원되는 채널에 추가하기 전과 이후에 업데이트합니다.

Red Hat이 지원되는 모든 릴리스에서 업데이트 권장 사항을 제거하는 경우 회귀 문제를 수정하는 향후 업데이트 권장 사항이 제공됩니다. 그러나 결함이 수정, 테스트 및 선택한 채널로 승격되는 동안 지연이 발생할 수 있습니다.

OpenShift Container Platform 4.10부터 업데이트 위험이 확인되면 관련 업데이트에 대한 조건부 업데이트 위험으로 선언됩니다. 알려진 각 위험은 모든 클러스터 또는 특정 조건과 일치하는 클러스터에만 적용될 수 있습니다. 몇 가지 예로는 Platform 이 None 으로 설정되거나 CNI 공급자를 OpenShiftSDN 으로 설정하는 것이 있습니다. CVO(Cluster Version Operator)는 현재 클러스터 상태에 대해 알려진 위험을 지속적으로 평가합니다. 위험이 일치하지 않는 경우 업데이트가 권장됩니다. 위험이 일치하면 해당 업데이트가 지원되지만 권장되지 않으며 참조 링크가 제공됩니다. 참조 링크는 클러스터 관리자가 위험을 수락했는지 여부 및 업데이트를 결정하는 데 도움이 됩니다.

Red Hat에서 조건부 업데이트 위험을 선언하도록 선택하면 해당 작업은 모든 관련 채널에서 동시에 수행됩니다. 조건부 업데이트 위험 선언은 업데이트가 지원되는 채널로 승격되기 전이나 후에 발생할 수 있습니다.

3.1.7. 클러스터에 적합한 채널 선택

적절한 채널을 선택하는 것은 두 가지 결정을 포함합니다.

먼저 클러스터 업데이트에 필요한 마이너 버전을 선택합니다. 현재 버전과 일치하는 채널을 선택하면 z-stream 업데이트만 적용하고 기능 업데이트가 제공되지 않습니다. 현재 버전보다 큰 버전이 있는 사용 가능한 채널을 선택하면 하나 이상의 업데이트가 끝나면 클러스터가 해당 버전으로 업데이트됩니다. 클러스터는 현재 버전, 다음 버전 또는 다음 EUS 버전과 일치하는 채널만 제공됩니다.

많은 마이너 버전 간의 업데이트 계획에 관련된 복잡성으로 인해 단일 EUS에서 EUS로의 업데이트 계획을 지원하는 채널은 제공되지 않습니다.

다음으로 원하는 롤아웃 전략을 선택해야 합니다. Red Hat에서 fast 채널을 선택하여 릴리스 GA를 선언하는 즉시 업데이트하거나 Red Hat이 stable 채널로 릴리스를 승격할 때까지 기다려야 할 수 있습니다. fast-4.12 및 stable-4.12 에서 제공되는 업데이트 권장 사항은 모두 완전히 지원되며 지속적인 데이터 분석으로 부터 동일한 이점을 얻을 수 있습니다. stable 채널로 릴리스를 승격하기 전에 승격 지연은 두 채널 간의 유일한 차이점을 나타냅니다. 최신 z-streams에 대한 업데이트는 일반적으로 1주일 또는 2일 내에 stable 채널로 승격되지만, 최신 마이너에 처음 업데이트를 롤아웃할 때 지연 시간은 일반적으로 45-90일입니다. stable 채널로 승격을 기다리는 경우 일정 계획에 영향을 줄 수 있으므로 원하는 채널을 선택할 때 승격 지연을 고려하십시오.

또한 조직이 클러스터를 fast 채널로 이동하게 할 수 있는 몇 가지 요인이 있습니다. 이는 영구적으로 또는 일시적으로 다음을 포함합니다.

- 지연 없이 환경에 영향을 미치는 것으로 알려진 특정 수정 사항을 적용하고자 합니다.

- 지연 없이 CVE 수정 사항 적용. CVE 수정으로 회귀 문제가 발생할 수 있으므로 CVE 수정 사항을 통해 승격 지연이 z-streams에 계속 적용됩니다.

- 내부 테스트 프로세스. 조직에서 릴리스를 확인하는 데 몇 주가 걸리면 대기하지 않고 프로모션 프로세스를 통해 동시에 테스트를 수행하는 것이 가장 좋습니다. 또한 Red Hat에 제공된 모든 Telemetry 신호가 롤아웃에 반영되므로 관련 문제를 보다 신속하게 해결할 수 있습니다.

3.1.8. 네트워크가 제한된 환경의 클러스터

OpenShift Container Platform 클러스터의 컨테이너 이미지를 직접 관리하는 경우 제품 릴리스와 관련된 Red Hat 에라타를 참조하고 업데이트에 영향을 미치는 의견을 기록해야합니다. 업데이트 중에 사용자 인터페이스에서 이러한 버전 간 전환에 대해 경고할 수 있으므로 이러한 경고를 무시하기 전에 적절한 버전을 선택했는지 확인해야 합니다.

3.1.9. 채널 간 전환

채널은 웹 콘솔에서 전환하거나 adm upgrade channel 명령을 통해 전환할 수 있습니다.

$ oc adm upgrade channel <channel>

현재 릴리스를 포함하지 않는 채널로 전환하면 웹 콘솔에 경고가 표시됩니다. 웹 콘솔은 현재 릴리스가 없는 채널에서 업데이트를 권장하지 않습니다. 하지만 언제든지 원래 채널로 돌아갈 수 있습니다.

채널을 변경하면 클러스터의 지원 가능성에 영향을 미칠 수 있습니다. 다음과 같은 조건이 적용될 수 있습니다.

-

stable-4.12채널에서fast-4.12채널로 변경해도 클러스터는 계속 지원됩니다. -

언제든지

candidate-4.12채널로 전환할 수 있지만 이 채널의 일부 릴리스는 지원되지 않을 수 있습니다. -

현재 릴리스가 정식 사용 버전 릴리스인 경우

candidate-4.12채널에서fast-4.12채널로 전환할 수 있습니다. -

항상

fast-4.12채널에서stable-4.12채널로 전환할 수 있습니다. 현재 릴리스가 최근 승격된 경우 릴리스가stable-4.12로 승격될 수 있는 최대 일 지연이 있습니다.

4장. OpenShift Container Platform 업데이트 기간 이해

OpenShift Container Platform 업데이트 기간은 배포 토폴로지에 따라 다릅니다. 이 페이지는 업데이트 기간에 영향을 미치는 요인을 이해하고 환경에서 클러스터 업데이트가 걸리는 시간을 추정하는 데 도움이 됩니다.

4.1. 사전 요구 사항

4.2. 업데이트 기간에 영향을 미치는 요소

다음 요소는 클러스터 업데이트 기간에 영향을 미칠 수 있습니다.

MCO(Machine Config Operator)의 새 머신 구성으로 컴퓨팅 노드를 재부팅

-

머신 구성 풀에서

MaxUnavailable의 값 - PDB(Pod 중단 예산)에 설정된 최소 복제본 수 또는 백분율

-

머신 구성 풀에서

- 클러스터의 노드 수

- 클러스터 노드의 상태

4.3. 클러스터 업데이트 단계

OpenShift Container Platform에서 클러스터 업데이트는 다음 두 단계로 수행됩니다.

- CVO(Cluster Version Operator) 대상 업데이트 페이로드 배포

- MCO(Machine Config Operator) 노드 업데이트

4.3.1. Cluster Version Operator 대상 업데이트 페이로드 배포

CVO(Cluster Version Operator)는 대상 업데이트 릴리스 이미지를 검색하고 클러스터에 적용합니다. 이 단계에서 Pod로 실행되는 모든 구성 요소가 업데이트되는 반면 호스트 구성 요소는 MCO(Machine Config Operator)에서 업데이트합니다. 이 프로세스에는 60~20분이 걸릴 수 있습니다.

업데이트의 CVO 단계는 노드를 재시작하지 않습니다.

추가 리소스

4.3.2. Machine Config Operator 노드 업데이트

MCO(Machine Config Operator)는 각 컨트롤 플레인 및 컴퓨팅 노드에 새 머신 구성을 적용합니다. 이 프로세스 중에 MCO는 클러스터의 각 노드에서 다음 작업을 수행합니다.

- 모든 노드를 드레인 (Cordon and drain all the nodes)

- 운영 체제 (OS) 업데이트

- 노드 재부팅

- 모든 노드 설정 해제 및 노드에 워크로드 예약

노드가 차단되면 워크로드를 예약할 수 없습니다.

이 프로세스를 완료하는 시간은 노드 및 인프라 구성을 비롯한 여러 요인에 따라 달라집니다. 이 프로세스는 노드당 완료하는 데 5분 이상 걸릴 수 있습니다.

MCO 외에도 다음 매개변수의 영향을 고려해야 합니다.

- 컨트롤 플레인 노드 업데이트 기간은 예측 가능하며, 컨트롤 플레인 워크로드가 정상 업데이트 및 빠른 드레인을 위해 조정되므로 컴퓨팅 노드보다 더 짧은 경우가 많습니다.

-

MCP(Machine Config Pool)에서

maxUnavailable필드를1이상으로 설정하여 컴퓨팅 노드를 병렬로 업데이트할 수 있습니다. MCO는 maxUnavailable에 지정된 노드 수를제한하고업데이트에 사용할 수 없는 것으로 표시합니다. -

MCP에서

maxUnavailable을 늘리면 풀이 더 빨리 업데이트할 수 있습니다. 그러나maxUnavailable이 너무 높고 여러 노드가 동시에 연결되면 예약 가능한 노드가 복제본을 실행하는 데 사용할 수 없으므로 Pod 중단 예산 (PDB) 보호 워크로드가 드레이닝되지 않을 수 있습니다. MCP에maxUnavailable을 늘리면 PDB 보호 워크로드가 드레인될 수 있도록 스케줄링 가능한 노드가 충분히 있는지 확인하십시오. 업데이트를 시작하기 전에 모든 노드를 사용할 수 있는지 확인해야 합니다. 노드가

maxUnavailable및 Pod 중단 예산에 영향을 미치므로 사용 불가능한 노드가 업데이트 기간에 상당한 영향을 미칠 수 있습니다.터미널에서 노드 상태를 확인하려면 다음 명령을 실행합니다.

$ oc get node

출력 예

NAME STATUS ROLES AGE VERSION ip-10-0-137-31.us-east-2.compute.internal Ready,SchedulingDisabled worker 12d v1.23.5+3afdacb ip-10-0-151-208.us-east-2.compute.internal Ready master 12d v1.23.5+3afdacb ip-10-0-176-138.us-east-2.compute.internal Ready master 12d v1.23.5+3afdacb ip-10-0-183-194.us-east-2.compute.internal Ready worker 12d v1.23.5+3afdacb ip-10-0-204-102.us-east-2.compute.internal Ready master 12d v1.23.5+3afdacb ip-10-0-207-224.us-east-2.compute.internal Ready worker 12d v1.23.5+3afdacb

노드 상태가

NotReady또는SchedulingDisabled인 경우 노드를 사용할 수 없으며 업데이트 기간에 영향을 미칩니다.컴퓨팅 → 노드를 확장하여 웹 콘솔의 관리자 화면에서 노드의 상태를 확인할 수 있습니다.

추가 리소스

4.4. 클러스터 업데이트 시간 추정

유사한 클러스터의 과거 업데이트 기간에서는 향후 클러스터 업데이트에 가장 적합한 추정치를 제공합니다. 그러나 기록 데이터를 사용할 수 없는 경우 다음 규칙을 사용하여 클러스터 업데이트 시간을 추정할 수 있습니다.

Cluster update time = CVO target update payload deployment time + (# node update iterations x MCO node update time)

노드 업데이트 반복은 병렬로 업데이트된 하나 이상의 노드로 구성됩니다. 컨트롤 플레인 노드는 항상 컴퓨팅 노드와 병렬로 업데이트됩니다. 또한 maxUnavailable 값에 따라 하나 이상의 계산 노드를 병렬로 업데이트할 수 있습니다.

예를 들어 업데이트 시간을 추정하려면 세 개의 컨트롤 플레인 노드와 컴퓨팅 노드가 6개인 OpenShift Container Platform 클러스터를 고려하여 각 호스트를 재부팅하는 데 약 5분이 걸립니다.

특정 노드를 재부팅하는 데 걸리는 시간은 크게 다릅니다. 클라우드 인스턴스에서 재부팅에는 약 1~2분이 걸릴 수 있지만, 물리적 베어 메탈 호스트에서는 재부팅에 15분이 걸릴 수 있습니다.

scenario-1

컨트롤 플레인과 컴퓨팅 노드 MCP(Machine Config Pool) 모두에 maxUnavailable 을 1 로 설정하면 6개의 모든 컴퓨팅 노드가 반복될 때마다 서로 업데이트합니다.

Cluster update time = 60 + (6 x 5) = 90 minutes

scenario-2

컴퓨팅 노드 MCP 에 maxUnavailable을 2 로 설정하면 각 반복에서 두 개의 컴퓨팅 노드가 병렬로 업데이트됩니다. 따라서 모든 노드를 업데이트하려면 총 세 번의 반복이 필요합니다.

Cluster update time = 60 + (3 x 5) = 75 minutes

maxUnavailable의 기본 설정 은 OpenShift Container Platform의 모든 MCP에 대해 1 입니다. 컨트롤 플레인 MCP에서 maxUnavailable을 변경 하지 않는 것이 좋습니다.

4.5. Red Hat Enterprise Linux (RHEL) 컴퓨팅 노드

Red Hat Enterprise Linux (RHEL) 컴퓨팅 노드는 노드 바이너리 구성 요소를 업데이트하려면 추가 openshift-ansible 을 사용해야 합니다. RHEL 컴퓨팅 노드를 업데이트하는 데 드는 실제 시간은 RHCOS(Red Hat Enterprise Linux CoreOS) 컴퓨팅 노드와 크게 다를 수 없습니다.

추가 리소스

5장. OpenShift Container Platform 4.12 업데이트 준비

OpenShift Container Platform 4.12에서는 더 이상 사용되지 않는 여러 API를 제거한 Kubernetes 1.25를 사용합니다.

클러스터 관리자는 OpenShift Container Platform 4.11에서 4.12로 클러스터를 업데이트하기 전에 수동 확인을 제공해야 합니다. 이는 OpenShift Container Platform 4.12로 업그레이드한 후 문제가 발생하지 않도록 하고, 여기에서 제거된 API는 여전히 클러스터에서 실행 중이거나 클러스터와 상호 작용하는 워크로드, 툴 또는 기타 구성 요소에서 사용되고 있습니다. 관리자는 제거될 모든 API에 대해 클러스터를 평가하고 영향을 받는 구성 요소를 마이그레이션하여 적절한 새 API 버전을 사용해야 합니다. 이 평가 및 마이그레이션이 완료되면 관리자는 승인을 제공할 수 있습니다.

OpenShift Container Platform 4.11 클러스터를 4.12로 업데이트하려면 먼저 관리자 확인을 제공해야 합니다.

5.1. 제거된 Kubernetes API

OpenShift Container Platform 4.12는 더 이상 사용되지 않는 다음과 같은 API를 제거한 Kubernetes 1.25를 사용합니다. 적절한 API 버전을 사용하려면 매니페스트 및 API 클라이언트를 마이그레이션해야 합니다. 제거된 API 마이그레이션에 대한 자세한 내용은 Kubernetes 설명서를 참조하십시오.

표 5.1. Kubernetes 1.25에서 제거된 API

| 리소스 | 제거된 API | 다음으로 마이그레이션 | 주요 변경 사항 |

|---|---|---|---|

|

|

|

| 없음 |

|

|

|

| |

|

|

|

| |

|

|

|

| 없음 |

|

|

|

| |

|

|

| ||

|

|

|

| 없음 |

- OpenShift Container Platform의 Pod 보안 승인에 대한 자세한 내용은 Pod 보안 승인 이해 및 관리를 참조하십시오.

추가 리소스

5.2. 제거된 API에 대한 클러스터 평가

관리자가 제거할 API 위치를 식별하는 데 도움이 되는 여러 가지 방법이 있습니다. 그러나 OpenShift Container Platform은 모든 인스턴스, 특히 유휴 상태인 워크로드 또는 사용되는 외부 툴을 식별할 수 없습니다. 관리자가 제거된 API 인스턴스에 대한 모든 워크로드 및 기타 통합을 적절하게 평가해야 합니다.

5.2.1. 제거된 API의 사용 식별을 위한 경고 검토

다음 릴리스에서 제거될 API가 사용 중인 경우 두 개의 경고가 발생합니다.

-

APIRemovedInNextReleaseInUse- OpenShift Container Platform의 다음 릴리스에서 제거될 API의 경우 -

APIRemovedIn다음 EUSReleaseInUse- OpenShift Container Platform EUS (Extended Update Support) 릴리스에서 제거될 API의 경우

이러한 경고 중 하나가 클러스터에서 실행 중인 경우 경고를 검토하고 새 API 버전을 사용하도록 매니페스트 및 API 클라이언트를 마이그레이션하여 경고를 지우는 조치를 취합니다.

경고에서 이 정보를 제공하지 않기 때문에 APIRequestCount API를 사용하여 사용 중인 API와 제거된 API를 사용하는 워크로드에 대한 자세한 정보를 얻을 수 있습니다. 또한 일부 API는 이러한 경고를 트리거하지 않을 수 있지만 여전히 APIRequestCount 에 의해 캡처됩니다. 프로덕션 시스템에서 부적절한 경고를 방지하기 위해 경고가 덜 민감하도록 조정됩니다.

5.2.2. APIRequestCount를 사용하여 제거된 API 사용 확인

APIRequestCount API를 사용하여 API 요청을 추적하고 제거된 API 중 하나를 사용 중인지 검토할 수 있습니다.

사전 요구 사항

-

cluster-admin역할의 사용자로 클러스터에 액세스할 수 있어야 합니다.

절차

다음 명령을 실행하고 출력의

REMOVEDINRELEASE열을 검사하여 현재 사용 중인 제거된 API를 확인합니다.$ oc get apirequestcounts

출력 예

NAME REMOVEDINRELEASE REQUESTSINCURRENTHOUR REQUESTSINLAST24H ... poddisruptionbudgets.v1.policy 391 8114 poddisruptionbudgets.v1beta1.policy 1.25 2 23 podmonitors.v1.monitoring.coreos.com 3 70 podnetworkconnectivitychecks.v1alpha1.controlplane.operator.openshift.io 612 11748 pods.v1 1531 38634 podsecuritypolicies.v1beta1.policy 1.25 3 39 podtemplates.v1 2 79 preprovisioningimages.v1alpha1.metal3.io 2 39 priorityclasses.v1.scheduling.k8s.io 12 248 prioritylevelconfigurations.v1beta1.flowcontrol.apiserver.k8s.io 1.26 3 86 ...

중요결과에 표시되는 다음 항목을 무시해도 됩니다.

-

system:serviceaccount:kube-system:generic-garbage-collector및system:serviceaccount:kube-system:namespace-controller사용자는 제거할 리소스를 검색할 때 등록된 모든 API를 호출하므로 결과에 표시될 수 있습니다. -

system:kube-controller-manager및system:cluster-policy-controller사용자는 다양한 정책을 적용하는 동안 모든 리소스를 진행하므로 결과에 나타날 수 있습니다.

-o jsonpath를 사용하여 결과를 필터링할 수도 있습니다.$ oc get apirequestcounts -o jsonpath='{range .items[?(@.status.removedInRelease!="")]}{.status.removedInRelease}{"\t"}{.metadata.name}{"\n"}{end}'출력 예

1.26 flowschemas.v1beta1.flowcontrol.apiserver.k8s.io 1.26 horizontalpodautoscalers.v2beta2.autoscaling 1.25 poddisruptionbudgets.v1beta1.policy 1.25 podsecuritypolicies.v1beta1.policy 1.26 prioritylevelconfigurations.v1beta1.flowcontrol.apiserver.k8s.io

-

5.2.3. APIRequestCount를 사용하여 제거된 API를 사용하는 워크로드 식별

지정된 API 버전에 대해 APIRequestCount 리소스를 검사하여 API를 사용하는 워크로드를 식별할 수 있습니다.

사전 요구 사항

-

cluster-admin역할의 사용자로 클러스터에 액세스할 수 있어야 합니다.

절차

다음 명령을 실행하고

username및userAgent필드를 검사하여 API를 사용하는 워크로드를 식별할 수 있습니다.$ oc get apirequestcounts <resource>.<version>.<group> -o yaml

예를 들면 다음과 같습니다.

$ oc get apirequestcounts poddisruptionbudgets.v1beta1.policy -o yaml

-o jsonpath를 사용하여APIRequestCount리소스에서사용자 이름및userAgent값을 추출할 수도 있습니다.$ oc get apirequestcounts poddisruptionbudgets.v1beta1.policy \ -o jsonpath='{range .status.currentHour..byUser[*]}{..byVerb[*].verb}{","}{.username}{","}{.userAgent}{"\n"}{end}' \ | sort -k 2 -t, -u | column -t -s, -NVERBS,USERNAME,USERAGENT출력 예

VERBS USERNAME USERAGENT watch system:serviceaccount:openshift-operators:3scale-operator manager/v0.0.0 watch system:serviceaccount:openshift-operators:datadog-operator-controller-manager manager/v0.0.0

5.3. 제거된 API의 인스턴스 마이그레이션

제거된 Kubernetes API를 마이그레이션하는 방법에 대한 자세한 내용은 Kubernetes 설명서의 사용 중단된 API 마이그레이션 가이드를 참조하십시오.

5.4. 관리자 확인 제공

제거된 API에 대해 클러스터를 평가하고 제거된 API를 마이그레이션한 후 클러스터가 OpenShift Container Platform 4.11에서 4.12로 업그레이드할 준비가 되었음을 인식할 수 있습니다.

이 관리자 승인을 제공하기 전에 제거된 API의 모든 사용이 해결되고 필요에 따라 마이그레이션되었는지 확인하는 모든 책임은 관리자에게 있음을 유의하십시오. OpenShift Container Platform은 평가를 지원할 수 있지만 제거된 API, 특히 유휴 워크로드 또는 외부 툴의 모든 사용을 식별할 수 없습니다.

사전 요구 사항

-

cluster-admin역할의 사용자로 클러스터에 액세스할 수 있어야 합니다.

절차

다음 명령을 실행하여 평가를 완료했으며 OpenShift Container Platform 4.12에서 Kubernetes API를 제거할 준비가 되었는지 확인합니다.

$ oc -n openshift-config patch cm admin-acks --patch '{"data":{"ack-4.11-kube-1.25-api-removals-in-4.12":"true"}}' --type=merge

6장. EUS-to-EUS 업데이트 수행 준비

기본 Kubernetes 설계로 인해 마이너 버전 간의 모든 OpenShift Container Platform 업데이트가 직렬화되어야 합니다. OpenShift Container Platform <4.y>에서 <4.y+1>으로 업데이트한 다음 <4.y+2>로 업데이트해야 합니다. OpenShift Container Platform <4.y>에서 <4.y+2>로 직접 업데이트할 수 없습니다. 그러나 EUS (Extended Update Support) 버전 두 개를 업데이트하려는 관리자는 컨트롤 플레인 호스트를 한 번만 재부팅할 수 있습니다.

EUS-to-EUS 업데이트는 OpenShift Container Platform의 짝수의 마이너 버전 사이에서만 가능합니다.

EUS-to-EUS 업데이트를 시도할 때 고려해야 할 몇 가지 경고 사항이 있습니다.

-

EUS (EUS) 업데이트는

stable채널에서 관련된 모든 버전 간의 업데이트 만 제공됩니다. - 홀수의 마이너 버전으로 업그레이드하는 동안 또는 이후에 문제가 발생하는 경우, 다음 짝수 번호의 버전으로 업그레이드하기 전에 이러한 문제를 해결하기 전에 이러한 문제를 해결하려면 앞으로 이동하기 전에 비 컨트롤 플레인 호스트가 홀수의 버전으로 업데이트를 완료해야 할 수 있습니다.

- 유지 관리에 걸리는 시간을 수용할 수 있도록 작업자 또는 사용자 지정 풀 노드를 업데이트하여 부분 업데이트를 수행할 수 있습니다.

- 중간 단계에서 일시 중지하여 여러 유지 관리 기간 동안 업데이트 프로세스를 완료할 수 있습니다. 그러나 60일 이내에 전체 업데이트를 완료할 계획입니다. 이는 인증서 교체와 관련된 일반 클러스터 자동화 프로세스를 포함하여 정상적인 클러스터 자동화 프로세스를 완료하는 데 중요합니다.

- 머신 구성 풀이 일시 중지되지 않고 업데이트가 완료되면 OpenShift Container Platform의 <4.y+1> 및 <4.y+2>의 일부 기능 및 버그 수정 사항을 사용할 수 없습니다.

-

모든 클러스터는 풀이 일시 중지되지 않고 기존 업데이트에 EUS 채널을 사용하여 업데이트할 수 있지만 컨트롤 플레인

MachineConfigPools개체가 없는 클러스터만 일시 중지된 풀에서 EUS-to-EUS 업데이트를 수행할 수 있습니다.

6.1. EUS-to-EUS 업데이트

다음 절차에서는 마스터 이외의 머신 구성 풀을 일시 정지하고 OpenShift Container Platform <4.y+1>에서 <4.y+1>으로 업데이트를 수행한 다음 이전에 일시 중지된 머신 구성 풀의 일시 정지를 해제합니다. 다음 절차에서는 총 업데이트 기간과 작업자 노드가 재시작되는 횟수를 줄입니다.

사전 요구 사항

- OpenShift Container Platform <4.y+1> 및 <4.y+2>의 릴리스 노트를 검토하십시오.

- 계층화된 제품 및 OLM(Operator Lifecycle Manager) Operator의 릴리스 노트 및 제품 라이프 사이클을 검토합니다. 일부는 EUS-to-EUS 업데이트 이전 또는 동안 업데이트가 필요할 수 있습니다.

- OpenShift Container Platform <4.y+1>에서 <4.y+2>로 업데이트하기 전에 필요한 사용되지 않는 API 제거와 같은 버전별 사전 요구 사항에 대해 잘 알고 있어야 합니다.

6.1.1. 웹 콘솔을 사용한 EUS-to-EUS 업데이트

사전 요구 사항

- 머신 구성 풀이 일시 중지되지 않았는지 확인합니다.

-

admin권한이 있는 사용자로 웹 콘솔에 액세스합니다.

절차

- 웹 콘솔의 관리자 화면을 사용하여 모든 OLM(Operator Lifecycle Manager) Operator를 업데이트된 버전과 호환되는 버전으로 업데이트합니다. "설치된 Operator 업데이트"에서 이 작업을 수행하는 방법에 대한 자세한 내용은 "ECDHE 리소스"를 참조하십시오.

모든 머신 구성 풀의 상태가

Up to date로 표시되고 머신 구성 풀이UPDATING상태를 표시하지 않는지 확인합니다.모든 머신 구성 풀의 상태를 보려면 Compute → MachineConfigPools 를 클릭하고 Update status 열의 내용을 확인합니다.

참고머신 구성 풀의 상태가

Updating인 경우 이 상태가Up to date로 변경될 때까지 기다립니다. 이 프로세스에는 몇 분이 걸릴 수 있습니다.채널을

eus-<4.y+2>로 설정합니다.채널을 설정하려면 Administration → Cluster Settings → Channel 을 클릭합니다. 현재 하이퍼링크된 채널을 클릭하여 채널을 편집할 수 있습니다.

- 마스터 풀을 제외한 모든 작업자 머신 풀을 일시 중지합니다. Compute 페이지의 MachineConfigPools 탭에서 이 작업을 수행할 수 있습니다. 일시 정지하고 업데이트 일시 정지를 클릭합니다.

- 버전 <4.y+1>으로 업데이트하고 저장 단계를 완료합니다. 웹 콘솔을 사용하여 "클러스터 업데이트"에서 이러한 작업을 수행하는 방법에 대한 자세한 내용은 "해결 리소스"를 참조하십시오.

- 마지막 완료된 버전의 클러스터를 확인하여 <4.y+1> 업데이트가 완료되었는지 확인합니다. 이 정보는 세부 정보 탭의 클러스터 설정 페이지에서 확인할 수 있습니다.

- 필요한 경우 웹 콘솔의 관리자 화면을 사용하여 OLM Operator를 업데이트합니다. 이러한 작업을 수행하는 방법에 대한 자세한 내용은 "설치된 Operator 업데이트"를 참조하십시오. "ECDHE 리소스"를 참조하십시오.

- 버전 <4.y+2>로 업데이트하고 저장 단계를 완료합니다. 웹 콘솔을 사용하여 "클러스터 업데이트"에서 이러한 작업을 수행하는 방법에 대한 자세한 내용은 "해결 리소스"를 참조하십시오.

- 클러스터의 마지막 완료된 버전을 확인하여 <4.y+2> 업데이트가 완료되었는지 확인합니다. 이 정보는 세부 정보 탭의 클러스터 설정 페이지에서 확인할 수 있습니다.

이전에 일시 중지된 모든 머신 구성 풀의 일시 정지를 해제합니다. Compute 페이지의 MachineConfigPools 탭에서 이 작업을 수행할 수 있습니다. 일시 정지 해제를 원하는 머신 구성 풀 옆에 있는 수직을 선택하고 업데이트 일시 정지 해제 를 클릭합니다.

중요풀이 일시 중지되지 않는 경우 클러스터는 향후 마이너 버전으로 업그레이드할 수 없으며 인증서 교체와 같은 유지 관리 작업이 금지됩니다. 이로 인해 클러스터가 나중에 저하될 위험이 있습니다.

이전에 일시 중지된 풀이 업데이트되고 클러스터가 <4.y+2> 버전으로 업데이트를 완료했는지 확인합니다.

Update status 의 값이 Up to date 인지 확인하여 Compute 페이지의 MachineConfigPools 탭에서 풀이 업데이트되었는지 확인할 수 있습니다.

마지막으로 완료된 클러스터 버전을 확인하여 클러스터가 업데이트를 완료 했는지 확인할 수 있습니다. 이 정보는 세부 정보 탭의 클러스터 설정 페이지에서 확인할 수 있습니다.

6.1.2. CLI를 사용한 EUS-to-EUS 업데이트

사전 요구 사항

- 머신 구성 풀이 일시 중지되지 않았는지 확인합니다.

-

업데이트할 때마다 OpenShift CLI(

oc)를 대상 버전으로 업데이트합니다.

이 사전 요구 사항을 생략하는 것은 매우 권장되지 않습니다. 업데이트 전에 OpenShift CLI(oc)가 대상 버전으로 업데이트되지 않으면 예기치 않은 문제가 발생할 수 있습니다.

절차

- 웹 콘솔의 관리자 화면을 사용하여 모든 OLM(Operator Lifecycle Manager) Operator를 업데이트된 버전과 호환되는 버전으로 업데이트합니다. "설치된 Operator 업데이트"에서 이 작업을 수행하는 방법에 대한 자세한 내용은 "ECDHE 리소스"를 참조하십시오.

모든 머신 구성 풀에

UPDATED상태가 표시되고 머신 구성 풀이UPDATING상태가 표시되는지 확인합니다. 모든 머신 구성 풀의 상태를 보려면 다음 명령을 실행합니다.$ oc get mcp

출력 예

NAME CONFIG UPDATED UPDATING master rendered-master-ecbb9582781c1091e1c9f19d50cf836c True False worker rendered-worker-00a3f0c68ae94e747193156b491553d5 True False

현재 버전은 <4.y>이며 원하는 버전은 <4.y+2>입니다. 다음 명령을 실행하여

eus-<4.y+2> 채널로 변경합니다.$ oc adm upgrade channel eus-<4.y+2>

참고eus-<4.y+2>가 사용 가능한 채널 중 하나가 아님을 나타내는 오류 메시지가 표시되면 Red Hat이 여전히 EUS 버전 업데이트를 롤아웃하고 있음을 나타냅니다. 이 롤아웃 프로세스는 일반적으로 GA 날짜부터 45-90일이 걸립니다.다음 명령을 실행하여 마스터 풀을 제외한 모든 작업자 머신 풀을 일시 중지합니다.

$ oc patch mcp/worker --type merge --patch '{"spec":{"paused":true}}'참고마스터 풀을 일시 중지할 수 없습니다.

다음 명령을 실행하여 최신 버전으로 업데이트합니다.

$ oc adm upgrade --to-latest

출력 예

Updating to latest version <4.y+1.z>

클러스터 버전을 검토하여 다음 명령을 실행하여 업데이트가 완료되었는지 확인합니다.

$ oc adm upgrade

출력 예

Cluster version is <4.y+1.z> ...

다음 명령을 실행하여 버전 <4.y+2>로 업데이트합니다.

$ oc adm upgrade --to-latest

클러스터 버전을 검색하여 다음 명령을 실행하여 <4.y+2> 업데이트가 완료되었는지 확인합니다.

$ oc adm upgrade

출력 예

Cluster version is <4.y+2.z> ...

작업자 노드를 <4.y+2>로 업데이트하려면 다음 명령을 실행하여 이전에 일시 중지된 모든 머신 구성 풀의 일시 중지를 해제합니다.

$ oc patch mcp/worker --type merge --patch '{"spec":{"paused":false}}'중요풀이 일시 정지되지 않으면 클러스터는 향후 마이너 버전으로 업데이트할 수 없으며 인증서 교체와 같은 유지 관리 작업이 억제됩니다. 이로 인해 클러스터가 나중에 저하될 위험이 있습니다.

다음 명령을 실행하여 이전에 일시 중지된 풀이 업데이트되고 버전 <4.y+2>로 업데이트가 완료되었는지 확인합니다.

$ oc get mcp

출력 예

NAME CONFIG UPDATED UPDATING master rendered-master-52da4d2760807cb2b96a3402179a9a4c True False worker rendered-worker-4756f60eccae96fb9dcb4c392c69d497 True False

추가 리소스

6.1.3. Operator Lifecycle Manager를 통해 설치된 계층화된 제품 및 Operator에 대한 EUS 업데이트

웹 콘솔 및 CLI에 대해 언급된 EUS-to-EUS 업데이트 단계 외에도 다음을 사용하여 클러스터에 대한 EUS-to-EUS 업데이트를 수행할 때 고려해야 할 추가 단계가 있습니다.

- 계층화된 제품

- OLM(Operator Lifecycle Manager)을 통해 설치된 Operator

계층화된 제품이란 무엇입니까?

계층화된 제품은 함께 사용하려고 하며 개별 서브스크립션으로 나눌 수 없는 여러 기본 제품으로 구성된 제품을 나타냅니다. 계층화된 OpenShift Container Platform 제품의 예는 OpenShift에서 계층화된 오퍼링을 참조하십시오.

계층화된 제품 클러스터 및 OLM을 통해 설치된 Operator에 대해 EUS-to-EUS 업데이트를 수행할 때 다음을 완료해야 합니다.

- OLM을 통해 이전에 설치된 모든 Operator가 최신 채널의 최신 버전으로 업데이트되었는지 확인합니다. Operator를 업데이트하면 클러스터 업데이트 중에 기본 OperatorHub 카탈로그가 현재 마이너 버전에서 다음 버전으로 전환될 때 유효한 업데이트 경로가 제공됩니다. Operator 업데이트 방법에 대한 자세한 내용은 "ECDHE 리소스"에서 "Operator 업데이트 준비"를 참조하십시오.

- 현재 및 의도된 Operator 버전 간의 클러스터 버전 호환성을 확인합니다. Red Hat OpenShift Container Platform Operator Update Information Checker 를 사용하여 OLM Operator가 호환되는 버전을 확인할 수 있습니다.

예를 들어 OpenShift Data Foundation (ODF)의 경우 <4.y>에서 <4.y+2>로 EUS 업데이트를 수행하는 단계는 다음과 같습니다. CLI 또는 웹 콘솔을 통해 이 작업을 수행할 수 있습니다. 원하는 인터페이스를 통해 클러스터를 업데이트하는 방법에 대한 자세한 내용은 웹 콘솔을 사용한 EUS 업데이트 및 "ECDHE 리소스"의 CLI를 사용하여 "EUS-to-EUS 업데이트"를 참조하십시오.

워크플로 예

- 작업자 시스템 풀을 일시 중지합니다.

- 업그레이드 OpenShift <4.y> → OpenShift <4.y+1>.

- 업그레이드 ODF <4.y> → ODF <4.y+1>.

- Upgrade OpenShift <4.y+1> → OpenShift <4.y+2>.

- ODF <4.y+2>로 업그레이드

- 작업자 시스템 풀의 일시 정지를 해제합니다.

ODF <4.y+2>로의 업그레이드는 작업자 머신 풀이 일시 정지되기 전이나 후에 발생할 수 있습니다.

7장. 수동으로 유지 관리되는 인증 정보로 클러스터 업데이트 준비

CCO(Cloud Credential Operator) 수동으로 유지 관리되는 인증 정보가 있는 클러스터의 Upgradable 상태는 기본적으로 False 입니다.

-

마이너 릴리스(예: 4.12에서 4.13로)의 경우 이 상태로 인해 업데이트된 권한을 처리하고

CloudCredential리소스에 주석을 달 때까지 업데이트하여 권한이 다음 버전에 필요에 따라 업데이트됨을 나타낼 수 없습니다. 이 주석은Upgradable상태를True로 변경합니다. - 예를 들어 4.13.0에서 4.13.1로 z-stream 릴리스의 경우 권한이 추가되거나 변경되지 않으므로 업데이트가 차단되지 않습니다.

수동으로 유지 관리되는 인증 정보로 클러스터를 업데이트하기 전에 업데이트 중인 OpenShift Container Platform 버전의 릴리스 이미지에 새 또는 변경된 인증 정보를 수용해야 합니다.

7.1. 수동으로 유지 관리되는 인증 정보를 사용하여 클러스터의 요구 사항 업데이트

CCO(Cloud Credential Operator)에서 수동으로 유지 관리되는 인증 정보를 사용하는 클러스터를 업데이트하기 전에 새 릴리스에 대한 클라우드 공급자 리소스를 업데이트해야 합니다.

CCO 유틸리티(ccoctlccoctl)를 사용하여 클러스터의 클라우드 인증 정보 관리가 구성된 경우 ccoctl 유틸리티를 사용하여 리소스를 업데이트합니다. ccoctl 유틸리티 없이 수동 모드를 사용하도록 구성된 클러스터에는 리소스에 대한 수동 업데이트가 필요합니다.

클라우드 공급자 리소스를 업데이트한 후 업데이트할 준비가 되었음을 나타내기 위해 클러스터에 대한 upgradeable-to 주석을 업데이트해야 합니다.

클라우드 공급자 리소스 및 upgradeable-to 주석을 업데이트하는 프로세스는 명령줄 툴을 사용하여만 완료할 수 있습니다.

7.1.1. 플랫폼 유형별 클라우드 인증 구성 옵션 및 업데이트 요구 사항

일부 플랫폼은 하나의 모드에서 CCO 사용만 지원합니다. 해당 플랫폼에 설치된 클러스터의 경우 플랫폼 유형에 따라 인증 정보 업데이트 요구 사항이 결정됩니다.

여러 모드에서 CCO 사용을 지원하는 플랫폼의 경우 클러스터가 사용하도록 구성된 모드를 결정하고 해당 구성에 필요한 작업을 수행해야 합니다.

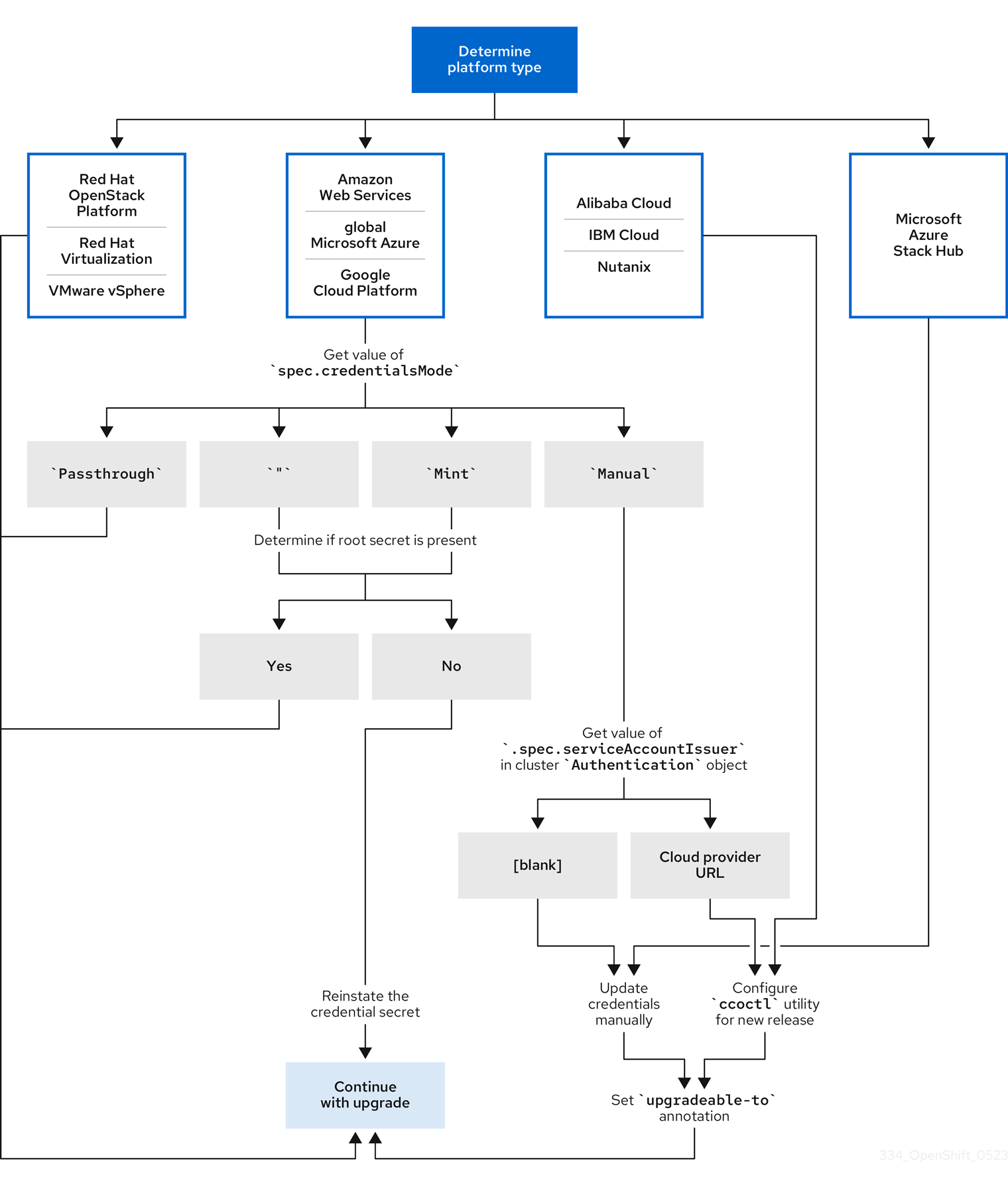

그림 7.1. 플랫폼 유형별 인증 정보 업데이트 요구사항

- RHOSP(Red Hat OpenStack Platform), RHV(Red Hat Virtualization) 및 VMware vSphere

이러한 플랫폼은 수동 모드에서 CCO 사용을 지원하지 않습니다. 이러한 플랫폼의 클러스터는 클라우드 공급자 리소스의 변경 사항을 자동으로 처리하고

upgradeable-to주석으로 업데이트할 필요가 없습니다.이러한 플랫폼에 있는 클러스터 관리자는 업데이트 프로세스의 수동으로 유지 관리되는 인증 정보 섹션을 건너뛰어야 합니다.

- CloudEvent Cloud, IBM Cloud, Nutanix

이러한 플랫폼에 설치된 클러스터는

ccoctl유틸리티를 사용하여 구성됩니다.이러한 플랫폼에 있는 클러스터 관리자는 다음 작업을 수행해야 합니다.

-

새 릴리스에 대해

ccoctl유틸리티를 구성합니다. -

ccoctl유틸리티를 사용하여 클라우드 공급자 리소스를 업데이트합니다. -

클러스터가

upgradeable-to주석을 사용하여 업데이트할 준비가 되었음을 나타냅니다.

-

새 릴리스에 대해

- Microsoft Azure Stack Hub

이러한 클러스터는 수명이 긴 인증 정보와 함께 수동 모드를 사용하며

ccoctl유틸리티를 사용하지 않습니다.이러한 플랫폼에 있는 클러스터 관리자는 다음 작업을 수행해야 합니다.

- 새 릴리스의 클라우드 공급자 리소스를 수동으로 업데이트합니다.

-

클러스터가

upgradeable-to주석을 사용하여 업데이트할 준비가 되었음을 나타냅니다.

- AWS(Amazon Web Services), 글로벌 Microsoft Azure 및 GCP(Google Cloud Platform)

이러한 플랫폼에 설치된 클러스터는 여러 CCO 모드를 지원합니다.

필수 업데이트 프로세스는 클러스터가 사용하도록 구성된 모드에 따라 다릅니다. CCO가 클러스터에서 사용하도록 구성된 모드가 확실하지 않은 경우 웹 콘솔 또는 CLI를 사용하여 이 정보를 확인할 수 있습니다.

7.1.2. 웹 콘솔을 사용하여 Cloud Credential Operator 모드 확인

웹 콘솔을 사용하여 CCO(Cloud Credential Operator)가 사용하도록 구성된 모드를 확인할 수 있습니다.

AWS(Amazon Web Services), 글로벌 Microsoft Azure 및 GCP(Google Cloud Platform) 클러스터만 여러 CCO 모드를 지원합니다.

사전 요구 사항

- 클러스터 관리자 권한이 있는 OpenShift Container Platform 계정에 액세스할 수 있습니다.

절차

-

cluster-admin역할의 사용자로 OpenShift Container Platform 웹 콘솔에 로그인합니다. - Administration → Cluster Settings으로 이동합니다.

- 클러스터 설정 페이지에서 구성 탭을 선택합니다.

- Configuration 리소스 에서 CloudCredential 를 선택합니다.

- CloudCredential 세부 정보 페이지에서 YAML 탭을 선택합니다.

YAML 블록에서

spec.credentialsMode의 값을 확인합니다. 다음 값이 모든 플랫폼에서 지원되지는 않지만 모두 지원되는 것은 아닙니다.-

'': CCO가 기본 모드에서 작동합니다. 이 구성에서 CCO는 설치 중에 제공된 인증 정보에 따라 Mint 또는 passthrough 모드에서 작동합니다. -

Mint: CCO가 Mint 모드에서 작동합니다. -

passthrough: CCO가 passthrough 모드에서 작동합니다. -

Manual: CCO가 수동 모드에서 작동합니다.

중요'',Mint또는Manual의spec.credentialsMode가 있는 AWS 또는 GCP 클러스터의 특정 구성을 확인하려면 추가 조사를 수행해야 합니다.AWS 및 GCP 클러스터는 루트 시크릿이 삭제된 상태에서 Mint 모드 사용을 지원합니다. 클러스터가 특별히 Mint 모드를 사용하도록 구성된 경우 또는 기본적으로 Mint 모드를 사용하는 경우 업데이트하기 전에 root 시크릿이 클러스터에 있는지 확인해야 합니다.

수동 모드를 사용하는 AWS 또는 GCP 클러스터는 AWS STS(Security Token Service) 또는 GCP 워크로드 ID를 사용하여 클러스터 외부에서 클라우드 인증 정보를 생성하고 관리하도록 구성할 수 있습니다. cluster

Authentication오브젝트를 검사하여 클러스터에서 이 전략을 사용하는지 확인할 수 있습니다.-

AWS 또는 GCP 클러스터만 Mint 모드를 사용하는: 클러스터가 루트 시크릿없이 작동하는지 확인하려면 워크로드 → 시크릿으로 이동하여 클라우드 공급자의 루트 시크릿을 찾습니다.

참고프로젝트 드롭다운이 All Projects 로 설정되어 있는지 확인합니다.

플랫폼 시크릿 이름 AWS

aws-credsGCP

gcp-credentials- 이러한 값 중 하나가 표시되면 클러스터에서 root 시크릿이 있는 mint 또는 passthrough 모드를 사용하는 것입니다.

- 이러한 값이 표시되지 않으면 클러스터는 루트 시크릿이 제거된 Mint 모드에서 CCO를 사용하는 것입니다.

AWS 또는 GCP 클러스터만 사용하는: 클러스터 외부에서 클라우드 인증 정보를 생성하고 관리하도록 클러스터가 구성되었는지 확인하려면 클러스터

인증오브젝트 YAML 값을 확인해야 합니다.- Administration → Cluster Settings으로 이동합니다.

- 클러스터 설정 페이지에서 구성 탭을 선택합니다.

- Configuration 리소스 에서 인증을 선택합니다.

- 인증 세부 정보 페이지에서 YAML 탭을 선택합니다.

YAML 블록에서

.spec.serviceAccountIssuer매개변수 값을 확인합니다.-

클라우드 공급자와 연결된 URL이 포함된 값은 CCO가 AWS STS 또는 GCP 워크로드 ID와 함께 수동 모드를 사용하여 클러스터 외부에서 클라우드 인증 정보를 생성하고 관리하는 것을 나타냅니다. 이러한 클러스터는

ccoctl유틸리티를 사용하여 구성됩니다. -

빈 값(

'')은 클러스터가 수동 모드에서 CCO를 사용하고 있지만ccoctl유틸리티를 사용하여 구성되지 않았음을 나타냅니다.

-

클라우드 공급자와 연결된 URL이 포함된 값은 CCO가 AWS STS 또는 GCP 워크로드 ID와 함께 수동 모드를 사용하여 클러스터 외부에서 클라우드 인증 정보를 생성하고 관리하는 것을 나타냅니다. 이러한 클러스터는

다음 단계

- Mint 또는 passthrough 모드에서 CCO가 작동하는 클러스터를 업데이트하고 루트 보안이 있는 경우 클라우드 공급자 리소스를 업데이트할 필요가 없으며 업데이트 프로세스의 다음 부분으로 계속 진행할 수 있습니다.

- 클러스터가 루트 시크릿이 제거된 상태에서 Mint 모드에서 CCO를 사용하는 경우 업데이트 프로세스의 다음 부분을 계속하기 전에 관리자 수준 인증 정보를 사용하여 인증 정보 시크릿을 복원해야 합니다.

CCO 유틸리티(

ccoctlccoctl )를 사용하여 클러스터가 구성된 경우 다음 작업을 수행해야 합니다.-

새 릴리스에 대해

ccoctl유틸리티를 구성하고 이를 사용하여 클라우드 공급자 리소스를 업데이트합니다. -

upgradeable-to주석을 업데이트하여 클러스터를 업데이트할 준비가 되었음을 나타냅니다.

-

새 릴리스에 대해

클러스터가 수동 모드에서 CCO를 사용하지만

ccoctl유틸리티를 사용하여 구성되지 않은 경우 다음 작업을 수행해야 합니다.- 새 릴리스의 클라우드 공급자 리소스를 수동으로 업데이트합니다.

-

upgradeable-to주석을 업데이트하여 클러스터를 업데이트할 준비가 되었음을 나타냅니다.

7.1.3. CLI를 사용하여 Cloud Credential Operator 모드 확인

CLI를 사용하여 CCO(Cloud Credential Operator)가 사용하도록 구성된 모드를 확인할 수 있습니다.

AWS(Amazon Web Services), 글로벌 Microsoft Azure 및 GCP(Google Cloud Platform) 클러스터만 여러 CCO 모드를 지원합니다.

사전 요구 사항

- 클러스터 관리자 권한이 있는 OpenShift Container Platform 계정에 액세스할 수 있습니다.

-

OpenShift CLI(

oc)가 설치되어 있습니다.

프로세스

-

cluster-admin역할의 사용자로 클러스터에서oc에 로그인합니다. CCO가 사용하도록 구성된 모드를 결정하려면 다음 명령을 입력합니다.

$ oc get cloudcredentials cluster \ -o=jsonpath={.spec.credentialsMode}다음 출력 값을 사용할 수 있지만 모든 플랫폼에서 모두 지원되는 것은 아닙니다.

-

'': CCO가 기본 모드에서 작동합니다. 이 구성에서 CCO는 설치 중에 제공된 인증 정보에 따라 Mint 또는 passthrough 모드에서 작동합니다. -

Mint: CCO가 Mint 모드에서 작동합니다. -

passthrough: CCO가 passthrough 모드에서 작동합니다. -

Manual: CCO가 수동 모드에서 작동합니다.

중요'',Mint또는Manual의spec.credentialsMode가 있는 AWS 또는 GCP 클러스터의 특정 구성을 확인하려면 추가 조사를 수행해야 합니다.AWS 및 GCP 클러스터는 루트 시크릿이 삭제된 상태에서 Mint 모드 사용을 지원합니다. 클러스터가 특별히 Mint 모드를 사용하도록 구성된 경우 또는 기본적으로 Mint 모드를 사용하는 경우 업데이트하기 전에 root 시크릿이 클러스터에 있는지 확인해야 합니다.

수동 모드를 사용하는 AWS 또는 GCP 클러스터는 AWS STS(Security Token Service) 또는 GCP 워크로드 ID를 사용하여 클러스터 외부에서 클라우드 인증 정보를 생성하고 관리하도록 구성할 수 있습니다. cluster

Authentication오브젝트를 검사하여 클러스터에서 이 전략을 사용하는지 확인할 수 있습니다.-

AWS 또는 GCP 클러스터만 Mint 모드를 사용하는: 클러스터가 루트 시크릿없이 작동하는지 확인하려면 다음 명령을 실행합니다.

$ oc get secret <secret_name> \ -n=kube-system

여기서 &

lt;secret_name>은 AWS의aws-creds이거나 GCP의gcp-credentials입니다.루트 시크릿이 있으면 이 명령의 출력에서 보안에 대한 정보를 반환합니다. root 보안이 클러스터에 존재하지 않음을 나타내는 오류가 있습니다.

수동 모드를 사용하는 AWS 또는 GCP 클러스터: 클러스터 외부에서 클라우드 인증 정보를 생성하고 관리하도록 클러스터가 구성되었는지 확인하려면 다음 명령을 실행합니다.

$ oc get authentication cluster \ -o jsonpath \ --template='{ .spec.serviceAccountIssuer }'이 명령은 클러스터

인증오브젝트에서.spec.serviceAccountIssuer매개변수 값을 표시합니다.-

클라우드 공급자와 연결된 URL의 출력은 CCO가 AWS STS 또는 GCP 워크로드 ID와 함께 수동 모드를 사용하여 클러스터 외부에서 클라우드 인증 정보를 생성하고 관리하는 것을 나타냅니다. 이러한 클러스터는

ccoctl유틸리티를 사용하여 구성됩니다. -

빈 출력은 클러스터가 수동 모드에서 CCO를 사용하고 있지만

ccoctl유틸리티를 사용하여 구성되지 않았음을 나타냅니다.

-

클라우드 공급자와 연결된 URL의 출력은 CCO가 AWS STS 또는 GCP 워크로드 ID와 함께 수동 모드를 사용하여 클러스터 외부에서 클라우드 인증 정보를 생성하고 관리하는 것을 나타냅니다. 이러한 클러스터는

다음 단계

- Mint 또는 passthrough 모드에서 CCO가 작동하는 클러스터를 업데이트하고 루트 보안이 있는 경우 클라우드 공급자 리소스를 업데이트할 필요가 없으며 업데이트 프로세스의 다음 부분으로 계속 진행할 수 있습니다.

- 클러스터가 루트 시크릿이 제거된 상태에서 Mint 모드에서 CCO를 사용하는 경우 업데이트 프로세스의 다음 부분을 계속하기 전에 관리자 수준 인증 정보를 사용하여 인증 정보 시크릿을 복원해야 합니다.

CCO 유틸리티(

ccoctlccoctl )를 사용하여 클러스터가 구성된 경우 다음 작업을 수행해야 합니다.-

새 릴리스에 대해

ccoctl유틸리티를 구성하고 이를 사용하여 클라우드 공급자 리소스를 업데이트합니다. -

upgradeable-to주석을 업데이트하여 클러스터를 업데이트할 준비가 되었음을 나타냅니다.

-

새 릴리스에 대해

클러스터가 수동 모드에서 CCO를 사용하지만

ccoctl유틸리티를 사용하여 구성되지 않은 경우 다음 작업을 수행해야 합니다.- 새 릴리스의 클라우드 공급자 리소스를 수동으로 업데이트합니다.

-

upgradeable-to주석을 업데이트하여 클러스터를 업데이트할 준비가 되었음을 나타냅니다.

7.2. 클러스터 업데이트에 대한 Cloud Credential Operator 유틸리티 구성

수동 모드에서 CCO(Cloud Credential Operator)를 사용하여 클러스터 외부에서 클라우드 인증 정보를 생성하고 관리하는 클러스터를 업그레이드하려면 CCO 유틸리티(ccoctl) 바이너리를 추출 및 준비합니다.

ccoctl 유틸리티는 Linux 환경에서 실행해야 하는 Linux 바이너리입니다.

전제 조건

- 클러스터 관리자 액세스 권한이 있는 OpenShift Container Platform 계정에 액세스할 수 있습니다.

-

OpenShift CLI(

oc)가 설치되어 있습니다.

-

클러스터는

ccoctl유틸리티를 사용하여 클러스터 외부에서 클라우드 인증 정보를 생성하고 관리했습니다.

프로세스

다음 명령을 실행하여 OpenShift Container Platform 릴리스 이미지를 가져옵니다.

$ RELEASE_IMAGE=$(./openshift-install version | awk '/release image/ {print $3}')다음 명령을 실행하여 OpenShift Container Platform 릴리스 이미지에서 CCO 컨테이너 이미지를 가져옵니다.

$ CCO_IMAGE=$(oc adm release info --image-for='cloud-credential-operator' $RELEASE_IMAGE -a ~/.pull-secret)

참고$RELEASE_IMAGE의 아키텍처가ccoctl툴을 사용할 환경의 아키텍처와 일치하는지 확인합니다.다음 명령을 실행하여 OpenShift Container Platform 릴리스 이미지 내의 CCO 컨테이너 이미지에서

ccoctl바이너리를 추출합니다.$ oc image extract $CCO_IMAGE --file="/usr/bin/ccoctl" -a ~/.pull-secret

다음 명령을 실행하여

ccoctl을 실행 가능하게 하려면 권한을 변경합니다.$ chmod 775 ccoctl

검증

ccoctl을 사용할 준비가 되었는지 확인하려면 다음 명령을 실행하여 도움말 파일을 표시합니다.$ ccoctl --help

ccoctl --help의 출력OpenShift credentials provisioning tool Usage: ccoctl [command] Available Commands: alibabacloud Manage credentials objects for alibaba cloud aws Manage credentials objects for AWS cloud gcp Manage credentials objects for Google cloud help Help about any command ibmcloud Manage credentials objects for IBM Cloud nutanix Manage credentials objects for Nutanix Flags: -h, --help help for ccoctl Use "ccoctl [command] --help" for more information about a command.

7.3. Cloud Credential Operator 유틸리티를 사용하여 클라우드 공급자 리소스 업데이트

CCO 유틸리티(ccoctl)를 사용하여 구성된 OpenShift Container Platform 클러스터를 업그레이드하는 프로세스는 설치 중에 클라우드 공급자 리소스를 생성하는 것과 유사합니다.

기본적으로 ccoctl은 명령이 실행되는 디렉터리에 오브젝트를 생성합니다. 다른 디렉터리에 오브젝트를 생성하려면 --output-dir 플래그를 사용합니다. 이 절차에서는 & lt;path_to_ccoctl_output_dir >을 사용하여 이 디렉터리를 참조합니다.

AWS 클러스터에서 일부 ccoctl 명령은 AWS API를 호출하여 AWS 리소스를 생성하거나 수정합니다. --dry-run 플래그를 사용하여 API 호출을 방지할 수 있습니다. 이 플래그를 사용하면 로컬 파일 시스템에 JSON 파일이 생성됩니다. JSON 파일을 검토 및 수정한 다음 --cli-input-json 매개변수를 사용하여 AWS CLI 툴로 적용할 수 있습니다.

사전 요구 사항

- 업그레이드할 버전의 OpenShift Container Platform 릴리스 이미지를 가져옵니다.

-

릴리스 이미지에서

ccoctl바이너리를 추출하고 준비합니다.

프로세스

다음 명령을 실행하여 OpenShift Container Platform 릴리스 이미지에서

CredentialsRequestCR(사용자 정의 리소스) 목록을 추출합니다.$ oc adm release extract --credentials-requests \ --cloud=<provider_type> \ --to=<path_to_directory_with_list_of_credentials_requests>/credrequests \ quay.io/<path_to>/ocp-release:<version>

다음과 같습니다.

-

<provider_type>은 클라우드 공급자의 값입니다. 유효한 값은alibabacloud,aws,gcp,ibmcloud,nutanix입니다. -

credrequests는CredentialsRequest오브젝트 목록이 저장되는 디렉터리입니다. 이 명령은 디렉터리가 없는 경우 해당 디렉터리를 생성합니다.

-

릴리스 이미지의 각

CredentialsRequestCR에 대해spec.secretRef.namespace필드의 텍스트와 일치하는 네임스페이스가 클러스터에 있는지 확인합니다. 이 필드에는 인증 정보 구성을 보유하는 생성된 시크릿이 저장됩니다.샘플 AWS

CredentialsRequest오브젝트apiVersion: cloudcredential.openshift.io/v1 kind: CredentialsRequest metadata: name: cloud-credential-operator-iam-ro namespace: openshift-cloud-credential-operator spec: providerSpec: apiVersion: cloudcredential.openshift.io/v1 kind: AWSProviderSpec statementEntries: - effect: Allow action: - iam:GetUser - iam:GetUserPolicy - iam:ListAccessKeys resource: "*" secretRef: name: cloud-credential-operator-iam-ro-creds namespace: openshift-cloud-credential-operator 1- 1

- 이 필드는 생성된 시크릿을 보유하기 위해 존재해야 하는 네임스페이스를 나타냅니다.

다른 플랫폼의

CredentialsRequestCR에는 다른 플랫폼별 값이 있는 유사한 형식이 있습니다.클러스터에

spec.secretRef.namespace에 지정된 이름이 있는 네임스페이스가 아직 없는CredentialsRequestCR에 대해 다음 명령을 실행하여 네임스페이스를 생성합니다.$ oc create namespace <component_namespace>

ccoctl툴을 사용하여 클라우드 공급자에 대한 명령을 실행하여credrequests디렉터리의 모든CredentialsRequest오브젝트를 처리합니다. 다음 명령은CredentialsRequest오브젝트를 처리합니다.-

CloudEvent Cloud:

ccoctl alibabacloud create-ram-users -

Amazon Web Services (AWS):

ccoctl aws create-iam-roles -

GCP(Google Cloud Platform):

ccoctl gcp create-all -

IBM Cloud:

ccoctl ibmcloud create-service-id -

Nutanix:

ccoctl nutanix create-shared-secrets

중요필요한 인수 및 특수 고려 사항에 대한 중요한 플랫폼별 세부 사항은 클라우드 공급자의 설치 콘텐츠의

ccoctl유틸리티 지침을 참조하십시오.각

CredentialsRequest오브젝트에 대해ccoctl은 OpenShift Container Platform 릴리스 이미지의 각CredentialsRequest오브젝트에 정의된 대로 필요한 공급자 리소스 및 권한 정책을 생성합니다.-

CloudEvent Cloud:

다음 명령을 실행하여 클러스터에 보안을 적용합니다.

$ ls <path_to_ccoctl_output_dir>/manifests/*-credentials.yaml | xargs -I{} oc apply -f {}

검증

클라우드 공급자를 쿼리하여 필요한 공급자 리소스 및 권한 정책이 생성되었는지 확인할 수 있습니다. 자세한 내용은 역할 또는 서비스 계정 나열에 대한 클라우드 공급자 설명서를 참조하십시오.

다음 단계

-

upgradeable-to주석을 업데이트하여 클러스터를 업그레이드할 준비가 되었음을 나타냅니다.

7.4. 수동으로 유지 관리되는 인증 정보로 클라우드 공급자 리소스 업데이트

수동으로 유지 관리되는 인증 정보로 클러스터를 업그레이드하기 전에 업그레이드할 릴리스 이미지에 대한 새 인증 정보를 생성해야 합니다. 기존 인증 정보에 필요한 권한을 검토하고 해당 구성 요소의 새 릴리스에 새 권한 요구 사항을 충족해야 합니다.

절차

새 릴리스에 대한

CredentialsRequest사용자 지정 리소스를 추출하고 검사합니다.클라우드 공급자의 설치 콘텐츠의 "Manually creating IAM" 섹션은 클라우드에 필요한 인증 정보를 얻고 사용하는 방법을 설명합니다.

클러스터에서 수동으로 유지 관리되는 인증 정보를 업데이트합니다.

-

새 릴리스 이미지에서 추가한

CredentialsRequest사용자 정의 리소스에 대한 새 시크릿을 생성합니다. -

시크릿에 저장된 기존 인증 정보에 대한

CredentialsRequest사용자 정의 리소스에 변경된 권한 요구 사항이 있는 경우 필요에 따라 권한을 업데이트합니다.

-

새 릴리스 이미지에서 추가한

클러스터에서 클러스터 기능을 사용하여 하나 이상의 선택적 구성 요소를 비활성화하는 경우 비활성화된 구성 요소에 대한

CredentialsRequest사용자 정의 리소스를 삭제합니다.AWS의 OpenShift Container Platform 4.12에 대한

credrequests디렉터리 콘텐츠 예0000_30_machine-api-operator_00_credentials-request.yaml 1 0000_50_cloud-credential-operator_05-iam-ro-credentialsrequest.yaml 2 0000_50_cluster-image-registry-operator_01-registry-credentials-request.yaml 3 0000_50_cluster-ingress-operator_00-ingress-credentials-request.yaml 4 0000_50_cluster-network-operator_02-cncc-credentials.yaml 5 0000_50_cluster-storage-operator_03_credentials_request_aws.yaml 6

GCP의 OpenShift Container Platform 4.12에 대한

credrequests디렉터리 콘텐츠 예0000_26_cloud-controller-manager-operator_16_credentialsrequest-gcp.yaml 1 0000_30_machine-api-operator_00_credentials-request.yaml 2 0000_50_cloud-credential-operator_05-gcp-ro-credentialsrequest.yaml 3 0000_50_cluster-image-registry-operator_01-registry-credentials-request-gcs.yaml 4 0000_50_cluster-ingress-operator_00-ingress-credentials-request.yaml 5 0000_50_cluster-network-operator_02-cncc-credentials.yaml 6 0000_50_cluster-storage-operator_03_credentials_request_gcp.yaml 7

다음 단계

-

upgradeable-to주석을 업데이트하여 클러스터를 업그레이드할 준비가 되었음을 나타냅니다.

7.5. 클러스터를 업그레이드할 준비가 되었음을 나타냅니다.

CCO(Cloud Credential Operator) 수동으로 유지 관리되는 인증 정보가 있는 클러스터의 Upgradable 상태는 기본적으로 False 입니다.

사전 요구 사항

-

업그레이드할 릴리스 이미지의 경우 새 인증 정보를 수동으로 처리하거나 Cloud Credential Operator 유틸리티(

ccoctl)를 사용하여 처리했습니다. -

OpenShift CLI(

oc)가 설치되어 있습니다.

프로세스

-

cluster-admin역할의 사용자로 클러스터에서oc에 로그인합니다. CloudCredential리소스를 편집하여 다음 명령을 실행하여metadata필드 내에upgradeable-to주석을 추가합니다.$ oc edit cloudcredential cluster

추가할 텍스트

... metadata: annotations: cloudcredential.openshift.io/upgradeable-to: <version_number> ...여기서

<version_number>는x.y.z형식으로 업그레이드할 버전입니다. 예를 들어 OpenShift Container Platform4.12.2에는 4.12.2를 사용합니다.주석을 추가한 후 업그레이드 가능 상태가 변경되는 데 몇 분이 소요될 수 있습니다.

검증

- 웹 콘솔의 관리자 화면에서 관리자 → 클러스터 설정으로 이동합니다.

CCO 상태 세부 정보를 보려면 Cluster Operators 목록에서 cloud-credential을 클릭합니다.

-

Conditions 섹션의 Upgradeable 상태가 False인 경우

upgradeable-to 주석에 오타 오류가 없는지 확인합니다.

-

Conditions 섹션의 Upgradeable 상태가 False인 경우

- Conditions 섹션의 Upgradeable 상태가 True 인 경우 OpenShift Container Platform 업그레이드를 시작합니다.

8장. 웹 콘솔을 사용하여 클러스터 업데이트

웹 콘솔을 사용하여 OpenShift Container Platform 클러스터에서 마이너 버전 및 패치 업데이트를 수행할 수 있습니다.

웹 콘솔 또는 oc adm upgrade channel <channel> 을 사용하여 업데이트 채널을 변경합니다. 4.12 채널을 변경한 후 업데이트를 완료하기 위해 CLI를 사용하여 클러스터 업데이트 단계를 실행할 수 있습니다.

8.1. 사전 요구 사항

-

admin권한이 있는 사용자로 클러스터에 액세스합니다. RBAC를 사용하여 권한 정의 및 적용을 참조하십시오. - 업데이트가 실패하고 클러스터를 이전 상태로 복원해야 하는 경우 최근 etcd 백업이 있어야 합니다.

- RHEL7 작업자 지원은 OpenShift Container Platform 4.12에서 제거되었습니다. OpenShift Container Platform 4.12로 업그레이드하기 전에 RHEL7 작업자를 RHEL8 또는 RHCOS 작업자로 교체해야 합니다. Red Hat은 RHEL 작업자의 인플레이스 RHEL7에서 RHEL8 업데이트를 지원하지 않습니다. 해당 호스트는 명확한 운영 체제 설치로 교체해야 합니다.

- OLM(Operator Lifecycle Manager)을 통해 이전에 설치된 모든 Operator가 최신 채널의 최신 버전으로 업데이트되었는지 확인합니다. Operator를 업데이트하면 클러스터 업데이트 중에 기본 OperatorHub 카탈로그가 현재 마이너 버전에서 다음 버전으로 전환될 때 유효한 업데이트 경로가 있습니다. 자세한 내용은 설치된 Operator 업데이트를 참조하십시오.

- 모든 MCP(Machine config pool)가 실행 중이고 일시 중지되지 않는지 확인합니다. 업데이트 프로세스 중에 일시 중지된 MCP와 연결된 노드를 건너뜁니다. 카나리아 롤아웃 업데이트 전략을 수행하는 경우 MCP를 일시 중지할 수 있습니다.

- 업데이트하는 데 걸리는 시간을 수용하기 위해 작업자 또는 사용자 지정 풀 노드를 업데이트하여 부분 업데이트를 수행할 수 있습니다. 각 풀의 진행률 표시줄 내에서 일시 중지하고 재개할 수 있습니다.

- 클러스터에서 수동으로 유지 관리되는 인증 정보를 사용하는 경우 새 릴리스의 클라우드 공급자 리소스를 업데이트합니다. 클러스터의 요구 사항인지 확인하는 방법을 포함하여 자세한 내용은 수동으로 유지 관리되는 인증 정보를 사용하여 클러스터 업데이트 준비를 참조하십시오.

- Kubernetes 1.25에서 제거된 API 목록을 검토하여 새 API 버전을 사용하도록 영향을 받는 구성 요소를 마이그레이션하고 관리자에게 승인한 내용을 제공합니다. 자세한 내용은 OpenShift Container Platform 4.12로 업데이트 준비를 참조하십시오.

-

Operator를 실행하거나 Pod 중단 예산을 사용하여 애플리케이션을 구성한 경우 업그레이드 프로세스 중에 중단될 수 있습니다.

PodDisruptionBudget에서minAvailable이 1로 설정된 경우 노드는 제거 프로세스를 차단할 수 있는 보류 중인 머신 구성을 적용하기 위해 드레인됩니다. 여러 노드가 재부팅되면 모든 Pod가 하나의 노드에서만 실행될 수 있으며PodDisruptionBudget필드에서 노드 드레이닝을 방지할 수 있습니다.

- 업데이트가 완료되지 않으면 CVO(Cluster Version Operator)에서 업데이트를 조정하는 동안 차단 구성 요소의 상태를 보고합니다. 클러스터를 이전 버전으로 롤백하는 것은 지원되지 않습니다. 업데이트가 완료되지 않으면 Red Hat 지원에 문의하십시오.

-

unsupportedConfigOverrides섹션을 사용하여 Operator 설정을 변경하는 것은 지원되지 않으며 클러스터 업데이트를 차단할 수 있습니다. 클러스터를 업데이트하기 전에 이 설정을 제거해야 합니다.

추가 리소스

8.2. 카나리아 롤아웃 업데이트 수행

일부 특정 사용 사례에서는 클러스터의 나머지 부분과 동시에 특정 노드를 업데이트하지 않도록 보다 제어된 업데이트 프로세스를 원할 수 있습니다. 이러한 사용 사례에는 다음이 포함되지만 이에 국한되지는 않습니다.

- 업데이트 중에 사용할 수 없는 미션크리티컬 애플리케이션이 있습니다. 업데이트 후 노드의 애플리케이션을 소규모로 천천히 테스트할 수 있습니다.

- 유지 보수 기간이 짧아서 모든 노드를 업데이트할 수 없거나 유지 보수 기간이 여러 개일 수 있습니다.

롤링 업데이트 프로세스는 일반적인 업데이트 워크플로우가 아닙니다. 대규모 클러스터를 사용하면 여러 명령을 실행해야 하는 시간이 많이 소요될 수 있습니다. 이러한 복잡성으로 인해 전체 클러스터에 영향을 줄 수 있는 오류가 발생할 수 있습니다. 롤링 업데이트를 사용할지 여부를 신중하게 고려하고 시작하기 전에 프로세스 구현을 신중하게 계획하는 것이 좋습니다.

이 주제에서 설명하는 롤링 업데이트 프로세스에는 다음이 포함됩니다.

- 하나 이상의 사용자 지정 MCP(Machine config pool) 생성.

- 해당 노드를 사용자 지정 MCP로 이동하기 위해 즉시 업데이트하지 않으려는 각 노드에 레이블을 지정.

- 해당 노드에 대한 업데이트를 방지하는 사용자 지정 MCP를 일시 중지.

- 클러스터 업데이트 수행.

- 해당 노드에서 업데이트를 트리거하는 하나의 사용자 지정 MCP를 일시 중지 해제.

- 해당 노드에서 애플리케이션을 테스트하여 새로 업데이트된 해당 노드에서 애플리케이션이 예상대로 작동하는지 확인.

- 선택적으로 나머지 노드에서 사용자 지정 레이블을 소규모 배치로 제거하고 해당 노드에서 애플리케이션을 테스트.

MCP를 일시 중지하면 Machine Config Operator에서 연결된 노드에 구성 변경 사항을 적용하지 못합니다. MCP를 일시 중지하면 kube-apiserver-to-kubelet-signer CA 인증서의 자동 CA 회전을 포함하여 자동으로 순환된 인증서가 연결된 노드로 푸시되지 않습니다.

kube-apiserver-to-kubelet-signer CA 인증서가 만료되고 MCO가 인증서를 자동으로 갱신하려고 하면 새 인증서가 생성되지만 해당 머신 구성 풀의 노드에 적용되지 않습니다. 이로 인해 oc debug, ,oc logsoc exec, oc attach 를 포함하여 여러 oc 명령에서 오류가 발생합니다. 인증서가 교체될 때 MCP가 일시 중지되면 OpenShift Container Platform 웹 콘솔의 경고 UI에 경고가 표시됩니다.

MCP 일시 중지는 kube-apiserver-to-kubelet-signer CA 인증서 만료에 대해 신중하게 고려하여 단기간 동안만 수행해야 합니다.

카나리아 롤아웃 업데이트 프로세스를 사용하려면 카나리아 롤아웃 업데이트 수행을 참조하십시오.

8.3. 수동으로 유지 관리되는 인증 정보로 클라우드 공급자 리소스 업데이트

수동으로 유지 관리되는 인증 정보로 클러스터를 업그레이드하기 전에 업그레이드할 릴리스 이미지에 대한 새 인증 정보를 생성해야 합니다. 기존 인증 정보에 필요한 권한을 검토하고 해당 구성 요소의 새 릴리스에 새 권한 요구 사항을 충족해야 합니다.

절차

새 릴리스에 대한

CredentialsRequest사용자 지정 리소스를 추출하고 검사합니다.클라우드 공급자의 설치 콘텐츠의 "Manually creating IAM" 섹션은 클라우드에 필요한 인증 정보를 얻고 사용하는 방법을 설명합니다.

클러스터에서 수동으로 유지 관리되는 인증 정보를 업데이트합니다.

-

새 릴리스 이미지에서 추가한

CredentialsRequest사용자 정의 리소스에 대한 새 시크릿을 생성합니다. -

시크릿에 저장된 기존 인증 정보에 대한

CredentialsRequest사용자 정의 리소스에 변경된 권한 요구 사항이 있는 경우 필요에 따라 권한을 업데이트합니다.

-

새 릴리스 이미지에서 추가한

클러스터에서 클러스터 기능을 사용하여 하나 이상의 선택적 구성 요소를 비활성화하는 경우 비활성화된 구성 요소에 대한

CredentialsRequest사용자 정의 리소스를 삭제합니다.AWS의 OpenShift Container Platform 4.12에 대한

credrequests디렉터리 콘텐츠 예0000_30_machine-api-operator_00_credentials-request.yaml 1 0000_50_cloud-credential-operator_05-iam-ro-credentialsrequest.yaml 2 0000_50_cluster-image-registry-operator_01-registry-credentials-request.yaml 3 0000_50_cluster-ingress-operator_00-ingress-credentials-request.yaml 4 0000_50_cluster-network-operator_02-cncc-credentials.yaml 5 0000_50_cluster-storage-operator_03_credentials_request_aws.yaml 6

GCP의 OpenShift Container Platform 4.12에 대한

credrequests디렉터리 콘텐츠 예0000_26_cloud-controller-manager-operator_16_credentialsrequest-gcp.yaml 1 0000_30_machine-api-operator_00_credentials-request.yaml 2 0000_50_cloud-credential-operator_05-gcp-ro-credentialsrequest.yaml 3 0000_50_cluster-image-registry-operator_01-registry-credentials-request-gcs.yaml 4 0000_50_cluster-ingress-operator_00-ingress-credentials-request.yaml 5 0000_50_cluster-network-operator_02-cncc-credentials.yaml 6 0000_50_cluster-storage-operator_03_credentials_request_gcp.yaml 7

다음 단계

-

upgradeable-to주석을 업데이트하여 클러스터를 업그레이드할 준비가 되었음을 나타냅니다.

8.4. 웹 콘솔을 사용하여 MachineHealthCheck 리소스 일시 중지

업그레이드 프로세스 중에 클러스터의 노드를 일시적으로 사용할 수 없게 될 수 있습니다. 작업자 노드의 경우 시스템 상태 점검에서 이러한 노드를 비정상으로 식별하고 재부팅할 수 있습니다. 이러한 노드를 재부팅하지 않으려면 클러스터를 업데이트하기 전에 모든 MachineHealthCheck 리소스를 일시 중지합니다.

사전 요구 사항

-

cluster-admin권한이 있는 클러스터에 액세스할 수 있습니다. - OpenShift Container Platform 웹 콘솔에 액세스할 수 있습니다.

프로세스

- OpenShift Container Platform 웹 콘솔에 로그인합니다.

- Compute → MachineHealthChecks 로 이동합니다.

머신 상태 점검을 일시 중지하려면 각

MachineHealthCheck리소스에cluster.x-k8s.io/paused=""주석을 추가합니다. 예를 들어machine-api-termination-handler리소스에 주석을 추가하려면 다음 단계를 완료합니다.-

machine-api-termination-handler옆에 있는 옵션 메뉴 를 클릭하고 주석 편집을 클릭합니다.

를 클릭하고 주석 편집을 클릭합니다.

- Edit annotations ( 주석 편집) 대화 상자에서 추가 를 클릭합니다.

-

Key 및 Value 필드에서

cluster.x-k8s.io/paused및""값을 각각 추가하고 저장 을 클릭합니다.

-

8.5. 단일 노드 OpenShift Container Platform 업데이트 정보

콘솔 또는 CLI를 사용하여 단일 노드 OpenShift Container Platform 클러스터를 업데이트하거나 업그레이드할 수 있습니다.

그러나 다음과 같은 제한 사항이 있습니다.

-

상태 점검을 수행할 다른 노드가 없기 때문에

MachineHealthCheck리소스를 일시 정지하기 위한 전제 조건은 필요하지 않습니다. - etcd 백업을 사용하여 단일 노드 OpenShift Container Platform 클러스터를 복원하는 것은 공식적으로 지원되지 않습니다. 그러나 업그레이드가 실패하는 경우 etcd 백업을 수행하는 것이 좋습니다. 컨트롤 플레인이 정상이면 백업을 사용하여 클러스터를 이전 상태로 복원할 수 있습니다.

단일 노드 OpenShift Container Platform 클러스터를 업데이트하려면 다운타임이 필요하며 자동 재부팅이 포함될 수 있습니다. 다운타임 양은 다음 시나리오에 설명된 업데이트 페이로드에 따라 다릅니다.

- 업데이트 페이로드에 재부팅이 필요한 운영 체제 업데이트가 포함된 경우 다운타임이 심각하고 클러스터 관리 및 사용자 워크로드에 영향을 미칩니다.

- 업데이트에 재부팅할 필요가 없는 머신 구성 변경 사항이 포함된 경우 다운타임이 줄어들며 클러스터 관리 및 사용자 워크로드에 미치는 영향은 줄어듭니다. 이 경우 워크로드를 다시 예약할 수 있는 다른 노드가 클러스터에 없기 때문에 단일 노드 OpenShift Container Platform을 사용하여 노드 드레이닝 단계를 건너뜁니다.

- 업데이트 페이로드에 운영 체제 업데이트 또는 머신 구성 변경 사항이 포함되어 있지 않으면 API 중단이 단축되고 신속하게 해결됩니다.

업데이트된 패키지의 버그와 같은 조건이 있어 재부팅 후 단일 노드가 다시 시작되지 않을 수 있습니다. 이 경우 업데이트가 자동으로 롤백되지 않습니다.

추가 리소스

- 재부팅이 필요한 머신 구성 변경에 대한 자세한 내용은 Machine Config Operator 이해를 참조하십시오.

8.6. 웹 콘솔을 사용하여 클러스터 업데이트

사용 가능한 업데이트가 있으면 웹 콘솔에서 클러스터를 업데이트할 수 있습니다.

사용 가능한 OpenShift Container Platform 권고 및 업데이트는 고객 포털의 에라타 섹션을 참조하십시오.

전제 조건

-

admin권한이 있는 사용자로 웹 콘솔에 액세스합니다. -

모든

MachineHealthCheck리소스를 일시 중지합니다.

프로세스

- 웹 콘솔에서 Administration → Cluster Settings을 클릭하고 Details 탭의 내용을 확인합니다.

프로덕션 클러스터의 경우 Channel 이

stable-4.12와 같이 업데이트하려는 버전에 대한 올바른 채널로 설정되어 있는지 확인합니다.중요프로덕션 클러스터의 경우

stable-*,eus-*또는fast-*채널에 가입해야 합니다.참고다음 마이너 버전으로 이동할 준비가 되면 해당 마이너 버전에 해당하는 채널을 선택합니다. 업데이트 채널을 더 많이 선언할수록 클러스터에서 대상 버전으로 경로를 업데이트하는 것이 좋습니다. 클러스터에서 사용 가능한 모든 업데이트를 평가하고 선택할 수 있는 최상의 업데이트 권장 사항을 제공하는 데 시간이 다소 걸릴 수 있습니다. 업데이트 권장 사항은 현재 사용 가능한 업데이트 옵션을 기반으로 하므로 시간이 지남에 따라 변경될 수 있습니다.

대상 마이너 버전의 업데이트 경로가 표시되지 않는 경우 경로에서 다음 마이너 버전을 사용할 수 있을 때까지 클러스터를 현재 버전의 최신 패치 릴리스로 계속 업데이트하십시오.

- Update status 가 Updates available 가 아닌 경우 클러스터를 업데이트할 수 없습니다.

- Select channel은 클러스터가 실행 중이거나 업데이트 중인 클러스터 버전을 나타냅니다.

업데이트할 버전을 선택하고 저장을 클릭합니다.

입력 채널 Update Status가 Update to <product-version> in progress로 변경되고 Operator 및 노드의 진행률을 확인하여 클러스터 업데이트의 진행 상황을 검토할 수 있습니다.

참고클러스터를 버전 4.y에서 4.(y+1)로 업그레이드하는 경우 새 기능을 사용하는 워크로드를 배포하기 전에 노드가 업데이트되었는지 확인하는 것이 좋습니다. 아직 업데이트되지 않은 작업자 노드가 있는 풀은 클러스터 설정 페이지에 표시됩니다.

업데이트가 완료되고 Cluster Version Operator가 사용 가능한 업데이트를 새로 고침한 후 현재 채널에서 사용 가능한 추가 업데이트가 있는지 확인합니다.

- 업데이트가 있는 경우 더 이상 업데이트할 수 없을 때까지 현재 채널에서 업데이트를 계속 수행합니다.

-

사용할 수 있는 업데이트가 없는 경우 채널을 다음 마이너 버전의

stable-*,eus-*또는fast-*채널로 변경하고 해당 채널에서 원하는 버전으로 업데이트합니다.

필요한 버전에 도달할 때까지 여러 중간 업데이트를 수행해야 할 수도 있습니다.

8.7. 웹 콘솔을 사용하여 업데이트 서버 변경

업데이트 서버 변경은 선택 사항입니다. 로컬에 설치되어 구성된 OSUS(OpenShift Update Service)가 있는 경우 업데이트 중에 로컬 서버를 사용하도록 서버의 URL을 upstream으로 설정해야 합니다.

프로세스

- 관리 → 클러스터 설정으로 이동하여 버전을 클릭합니다.

YAML 탭을 클릭한 다음

업스트림매개변수 값을 편집합니다.출력 예

... spec: clusterID: db93436d-7b05-42cc-b856-43e11ad2d31a upstream: '<update-server-url>' 1 ...- 1

<update-server-url>변수는 업데이트 서버의 URL을 지정합니다.

기본

upstream은https://api.openshift.com/api/upgrades_info/v1/graph입니다.- 저장을 클릭합니다.

추가 리소스

9장. CLI를 사용하여 클러스터 업데이트

OpenShift CLI(oc)를 사용하여 OpenShift Container Platform 클러스터에서 마이너 버전 및 패치 업데이트를 수행할 수 있습니다.

9.1. 사전 요구 사항

-

admin권한이 있는 사용자로 클러스터에 액세스합니다. RBAC를 사용하여 권한 정의 및 적용을 참조하십시오. - 업데이트가 실패하고 클러스터를 이전 상태로 복원해야 하는 경우 최근 etcd 백업이 있어야 합니다.

- RHEL7 작업자 지원은 OpenShift Container Platform 4.12에서 제거되었습니다. OpenShift Container Platform 4.12로 업그레이드하기 전에 RHEL7 작업자를 RHEL8 또는 RHCOS 작업자로 교체해야 합니다. Red Hat은 RHEL 작업자의 인플레이스 RHEL7에서 RHEL8 업데이트를 지원하지 않습니다. 해당 호스트는 명확한 운영 체제 설치로 교체해야 합니다.

- OLM(Operator Lifecycle Manager)을 통해 이전에 설치된 모든 Operator가 최신 채널의 최신 버전으로 업데이트되었는지 확인합니다. Operator를 업데이트하면 클러스터 업데이트 중에 기본 OperatorHub 카탈로그가 현재 마이너 버전에서 다음 버전으로 전환될 때 유효한 업데이트 경로가 있습니다. 자세한 내용은 설치된 Operator 업데이트를 참조하십시오.

- 모든 MCP(Machine config pool)가 실행 중이고 일시 중지되지 않는지 확인합니다. 업데이트 프로세스 중에 일시 중지된 MCP와 연결된 노드를 건너뜁니다. 카나리아 롤아웃 업데이트 전략을 수행하는 경우 MCP를 일시 중지할 수 있습니다.

- 클러스터에서 수동으로 유지 관리되는 인증 정보를 사용하는 경우 새 릴리스의 클라우드 공급자 리소스를 업데이트합니다. 클러스터의 요구 사항인지 확인하는 방법을 포함하여 자세한 내용은 수동으로 유지 관리되는 인증 정보를 사용하여 클러스터 업데이트 준비를 참조하십시오.

-

클러스터가 다음 마이너 버전으로 업데이트할 수 있도록 모든

Upgradeable=False조건을 해결해야 합니다. 업그레이드할 수 없는 클러스터 Operator가 하나 이상 있는 경우 클러스터 설정 페이지 상단에 경고가 표시됩니다. 현재 사용 중인 마이너 릴리스에 대해 사용 가능한 다음 패치 업데이트로 계속 업데이트할 수 있습니다. - Kubernetes 1.25에서 제거된 API 목록을 검토하여 새 API 버전을 사용하도록 영향을 받는 구성 요소를 마이그레이션하고 관리자에게 승인한 내용을 제공합니다. 자세한 내용은 OpenShift Container Platform 4.12로 업데이트 준비를 참조하십시오.

-

Operator를 실행하거나 Pod 중단 예산을 사용하여 애플리케이션을 구성한 경우 업그레이드 프로세스 중에 중단될 수 있습니다.

PodDisruptionBudget에서minAvailable이 1로 설정된 경우 노드는 제거 프로세스를 차단할 수 있는 보류 중인 머신 구성을 적용하기 위해 드레인됩니다. 여러 노드가 재부팅되면 모든 Pod가 하나의 노드에서만 실행될 수 있으며PodDisruptionBudget필드에서 노드 드레이닝을 방지할 수 있습니다.

- 업데이트가 완료되지 않으면 CVO(Cluster Version Operator)에서 업데이트를 조정하는 동안 차단 구성 요소의 상태를 보고합니다. 클러스터를 이전 버전으로 롤백하는 것은 지원되지 않습니다. 업데이트가 완료되지 않으면 Red Hat 지원에 문의하십시오.

-

unsupportedConfigOverrides섹션을 사용하여 Operator 설정을 변경하는 것은 지원되지 않으며 클러스터 업데이트를 차단할 수 있습니다. 클러스터를 업데이트하기 전에 이 설정을 제거해야 합니다.

추가 리소스

9.2. MachineHealthCheck 리소스 일시 중지

업그레이드 프로세스 중에 클러스터의 노드를 일시적으로 사용할 수 없게 될 수 있습니다. 작업자 노드의 경우 시스템 상태 점검에서 이러한 노드를 비정상으로 식별하고 재부팅할 수 있습니다. 이러한 노드를 재부팅하지 않으려면 클러스터를 업데이트하기 전에 모든 MachineHealthCheck 리소스를 일시 중지합니다.

사전 요구 사항

-

OpenShift CLI(

oc)를 설치합니다.

프로세스

일시 중지하려는 사용 가능한

MachineHealthCheck리소스를 모두 나열하려면 다음 명령을 실행합니다.$ oc get machinehealthcheck -n openshift-machine-api

머신 상태 점검을 일시 중지하려면

cluster.x-k8s.io/paused=""주석을MachineHealthCheck리소스에 추가합니다. 다음 명령을 실행합니다.$ oc -n openshift-machine-api annotate mhc <mhc-name> cluster.x-k8s.io/paused=""

주석이 지정된

MachineHealthCheck리소스는 다음 YAML 파일과 유사합니다.apiVersion: machine.openshift.io/v1beta1 kind: MachineHealthCheck metadata: name: example namespace: openshift-machine-api annotations: cluster.x-k8s.io/paused: "" spec: selector: matchLabels: role: worker unhealthyConditions: - type: "Ready" status: "Unknown" timeout: "300s" - type: "Ready" status: "False" timeout: "300s" maxUnhealthy: "40%" status: currentHealthy: 5 expectedMachines: 5중요클러스터를 업데이트한 후 머신 상태 점검을 다시 시작합니다. 검사를 다시 시작하려면 다음 명령을 실행하여

MachineHealthCheck리소스에서 일시 중지 주석을 제거합니다.$ oc -n openshift-machine-api annotate mhc <mhc-name> cluster.x-k8s.io/paused-

9.3. 단일 노드 OpenShift Container Platform 업데이트 정보

콘솔 또는 CLI를 사용하여 단일 노드 OpenShift Container Platform 클러스터를 업데이트하거나 업그레이드할 수 있습니다.

그러나 다음과 같은 제한 사항이 있습니다.

-

상태 점검을 수행할 다른 노드가 없기 때문에

MachineHealthCheck리소스를 일시 정지하기 위한 전제 조건은 필요하지 않습니다. - etcd 백업을 사용하여 단일 노드 OpenShift Container Platform 클러스터를 복원하는 것은 공식적으로 지원되지 않습니다. 그러나 업그레이드가 실패하는 경우 etcd 백업을 수행하는 것이 좋습니다. 컨트롤 플레인이 정상이면 백업을 사용하여 클러스터를 이전 상태로 복원할 수 있습니다.

단일 노드 OpenShift Container Platform 클러스터를 업데이트하려면 다운타임이 필요하며 자동 재부팅이 포함될 수 있습니다. 다운타임 양은 다음 시나리오에 설명된 업데이트 페이로드에 따라 다릅니다.

- 업데이트 페이로드에 재부팅이 필요한 운영 체제 업데이트가 포함된 경우 다운타임이 심각하고 클러스터 관리 및 사용자 워크로드에 영향을 미칩니다.

- 업데이트에 재부팅할 필요가 없는 머신 구성 변경 사항이 포함된 경우 다운타임이 줄어들며 클러스터 관리 및 사용자 워크로드에 미치는 영향은 줄어듭니다. 이 경우 워크로드를 다시 예약할 수 있는 다른 노드가 클러스터에 없기 때문에 단일 노드 OpenShift Container Platform을 사용하여 노드 드레이닝 단계를 건너뜁니다.

- 업데이트 페이로드에 운영 체제 업데이트 또는 머신 구성 변경 사항이 포함되어 있지 않으면 API 중단이 단축되고 신속하게 해결됩니다.

업데이트된 패키지의 버그와 같은 조건이 있어 재부팅 후 단일 노드가 다시 시작되지 않을 수 있습니다. 이 경우 업데이트가 자동으로 롤백되지 않습니다.

추가 리소스

- 재부팅이 필요한 머신 구성 변경에 대한 자세한 내용은 Machine Config Operator 이해를 참조하십시오.

9.4. CLI를 사용하여 클러스터 업데이트

OpenShift CLI(oc)를 사용하여 클러스터 업데이트를 검토하고 요청할 수 있습니다.

사용 가능한 OpenShift Container Platform 권고 및 업데이트는 고객 포털의 에라타 섹션을 참조하십시오.

전제 조건

-

업데이트된 버전과 일치하는 OpenShift CLI (

oc)를 설치합니다. -

cluster-admin권한이 있는 사용자로 클러스터에 로그인합니다. -

모든

MachineHealthCheck리소스를 일시 중지합니다.

프로세스

사용 가능한 업데이트를 확인하고 적용하려는 업데이트의 버전 번호를 기록해 둡니다.

$ oc adm upgrade

출력 예

Cluster version is 4.9.23 Upstream is unset, so the cluster will use an appropriate default. Channel: stable-4.9 (available channels: candidate-4.10, candidate-4.9, fast-4.10, fast-4.9, stable-4.10, stable-4.9, eus-4.10) Recommended updates: VERSION IMAGE 4.9.24 quay.io/openshift-release-dev/ocp-release@sha256:6a899c54dda6b844bb12a247e324a0f6cde367e880b73ba110c056df6d018032 4.9.25 quay.io/openshift-release-dev/ocp-release@sha256:2eafde815e543b92f70839972f585cc52aa7c37aa72d5f3c8bc886b0fd45707a 4.9.26 quay.io/openshift-release-dev/ocp-release@sha256:3ccd09dd08c303f27a543351f787d09b83979cd31cf0b4c6ff56cd68814ef6c8 4.9.27 quay.io/openshift-release-dev/ocp-release@sha256:1c7db78eec0cf05df2cead44f69c0e4b2c3234d5635c88a41e1b922c3bedae16 4.9.28 quay.io/openshift-release-dev/ocp-release@sha256:4084d94969b186e20189649b5affba7da59f7d1943e4e5bc7ef78b981eafb7a8 4.9.29 quay.io/openshift-release-dev/ocp-release@sha256:b04ca01d116f0134a102a57f86c67e5b1a3b5da1c4a580af91d521b8fa0aa6ec 4.9.31 quay.io/openshift-release-dev/ocp-release@sha256:2a28b8ebb53d67dd80594421c39e36d9896b1e65cb54af81fbb86ea9ac3bf2d7 4.9.32 quay.io/openshift-release-dev/ocp-release@sha256:ecdb6d0df547b857eaf0edb5574ddd64ca6d9aff1fa61fd1ac6fb641203bedfa

참고- 사용 가능한 업데이트가 없는 경우 지원되지만 권장되지 않는 업데이트는 계속 사용할 수 있습니다. 자세한 내용은 조건부 업데이트 경로를 따라 업데이트를 참조하십시오.

-

EUS-to-EUS채널 업데이트를 수행하는 방법에 대한 자세한 내용 및 자세한 내용은 추가 리소스 섹션에 나열된 EUS-to-EUS 업그레이드 준비 페이지를 참조하십시오.

조직 요구 사항에 따라 적절한 업데이트 채널을 설정합니다. 예를 들어 채널을

stable-4.13또는fast-4.13으로 설정할 수 있습니다. 채널에 대한 자세한 내용은 추가 리소스 섹션에 나열된 업데이트 채널 및 릴리스 이해 를 참조하십시오.$ oc adm upgrade channel <channel>

예를 들어 채널을

stable-4.12로 설정하려면 다음을 수행합니다.$ oc adm upgrade channel stable-4.12

중요프로덕션 클러스터의 경우

stable-*,eus-*또는fast-*채널에 가입해야합니다.참고다음 마이너 버전으로 이동할 준비가 되면 해당 마이너 버전에 해당하는 채널을 선택합니다. 업데이트 채널을 더 많이 선언할수록 클러스터에서 대상 버전으로 경로를 업데이트하는 것이 좋습니다. 클러스터에서 사용 가능한 모든 업데이트를 평가하고 선택할 수 있는 최상의 업데이트 권장 사항을 제공하는 데 시간이 다소 걸릴 수 있습니다. 업데이트 권장 사항은 현재 사용 가능한 업데이트 옵션을 기반으로 하므로 시간이 지남에 따라 변경될 수 있습니다.

대상 마이너 버전의 업데이트 경로가 표시되지 않는 경우 경로에서 다음 마이너 버전을 사용할 수 있을 때까지 클러스터를 현재 버전의 최신 패치 릴리스로 계속 업데이트하십시오.

업데이트를 적용합니다.