인증 및 권한 부여

사용자 및 서비스에 대한 사용자 인증 및 액세스 제어 구성

초록

1장. 인증 및 권한 부여 개요

1.1. OpenShift Container Platform 인증 및 권한 부여에 대한 일반 용어

이 용어집은 OpenShift Container Platform 인증 및 권한 부여에 사용되는 일반적인 용어를 정의합니다.

- 인증

- 인증에 따라 OpenShift Container Platform 클러스터에 대한 액세스 권한이 결정되며 인증된 사용자만 OpenShift Container Platform 클러스터에 액세스할 수 있습니다.

- 권한 부여

- 권한 부여는 식별된 사용자에게 요청된 작업을 수행할 수 있는 권한이 있는지 여부를 결정합니다.

- 전달자 토큰

-

전달자 토큰은 헤더

Authorization: Bearer <token>을 사용하여 API를 인증하는 데 사용됩니다. - Cloud Credential Operator

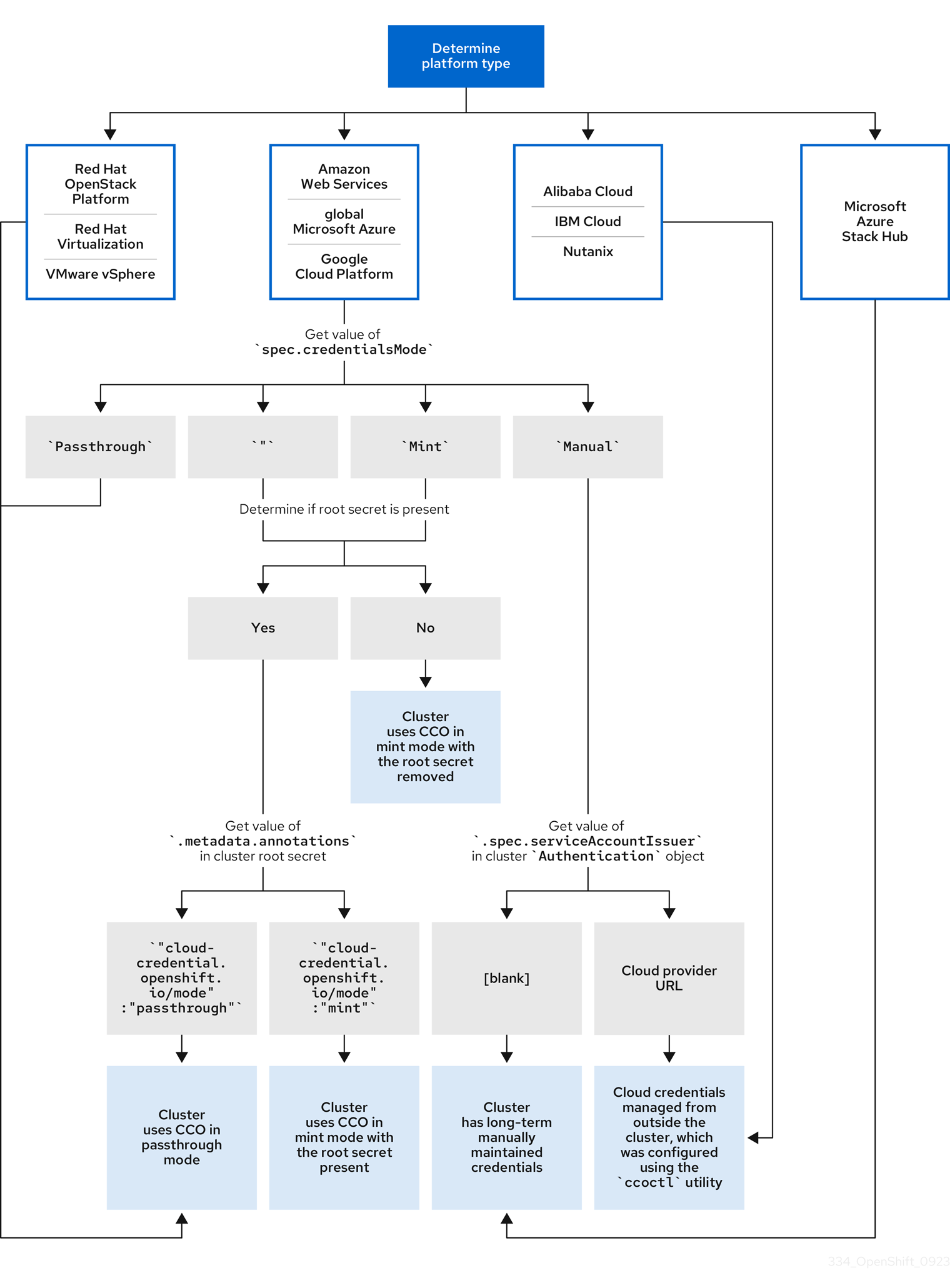

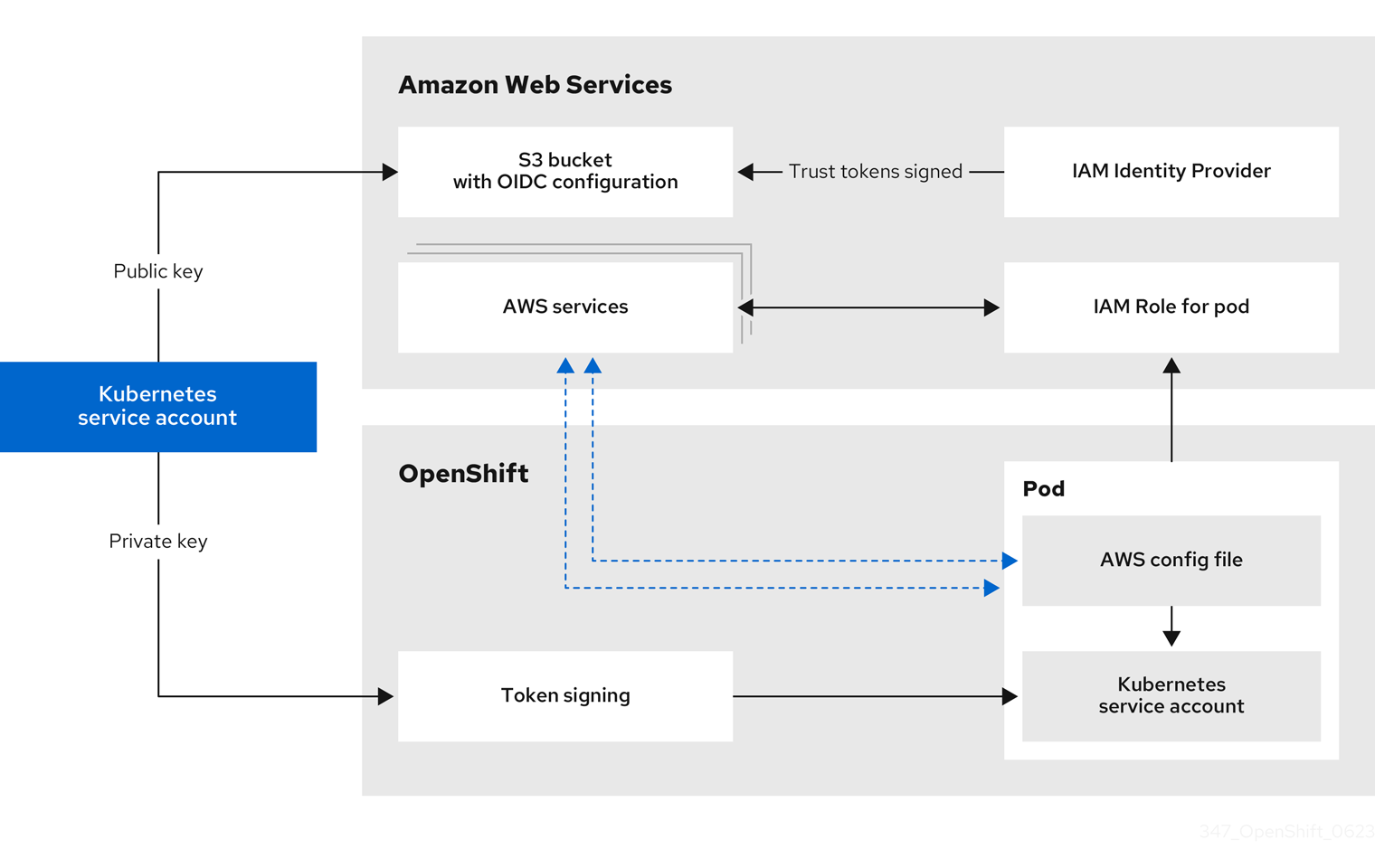

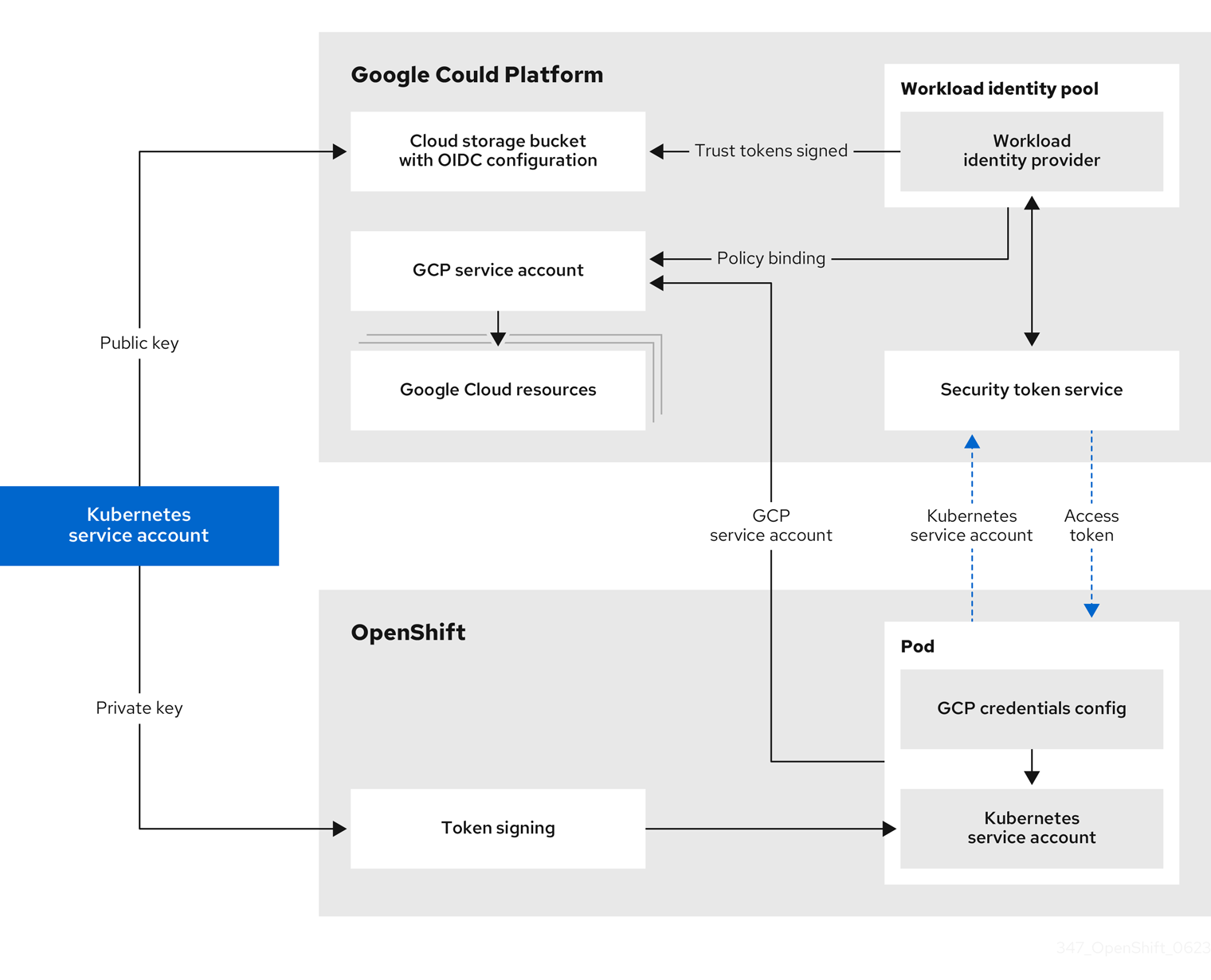

- CCO(Cloud Credential Operator)는 클라우드 공급자 인증 정보를 CRD(사용자 지정 리소스 정의)로 관리합니다.

- 구성 맵

-

구성 맵에서는 구성 데이터를 Pod에 삽입하는 방법을 제공합니다. 구성 맵에 저장된 데이터를

ConfigMap유형의 볼륨에서 참조할 수 있습니다. Pod에서 실행되는 애플리케이션에서는 이 데이터를 사용할 수 있습니다. - 컨테이너

- 소프트웨어 및 모든 종속 항목을 구성하는 경량 및 실행 가능한 이미지입니다. 컨테이너는 운영 체제를 가상화하므로 데이터 센터, 퍼블릭 또는 프라이빗 클라우드 또는 로컬 호스트에서 컨테이너를 실행할 수 있습니다.

- CR(사용자 정의 리소스)

- CR은 Kubernetes API의 확장입니다.

- group

- 그룹은 사용자 집합입니다. 그룹은 여러 사용자에게 한 번 권한을 부여하는 데 유용합니다.

- HTPasswd

- htpasswd는 HTTP 사용자 인증을 위해 사용자 이름 및 암호를 저장하는 파일을 업데이트합니다.

- Keystone

- Keystone은 ID, 토큰, 카탈로그 및 정책 서비스를 제공하는 RHOSP(Red Hat OpenStack Platform) 프로젝트입니다.

- LDAP(Lightweight Directory Access Protocol)

- LDAP는 사용자 정보를 쿼리하는 프로토콜입니다.

- 수동 모드

- 수동 모드에서 사용자는 CCO(Cloud Credential Operator) 대신 클라우드 인증 정보를 관리합니다.

- Mint 모드

- Mint 모드는 지원되는 플랫폼에서 사용할 CCO(Cloud Credential Operator)에 대한 기본 권장 모범 사례 설정입니다. 이 모드에서 CCO는 제공된 관리자 수준 클라우드 인증 정보를 사용하여 필요한 특정 권한만으로 클러스터의 구성 요소에 대한 새 인증 정보를 생성합니다.

- namespace

- 네임스페이스는 모든 프로세스에 표시되는 특정 시스템 리소스를 격리합니다. 네임스페이스 내에서 해당 네임스페이스의 멤버인 프로세스만 해당 리소스를 볼 수 있습니다.

- node

- 노드는 OpenShift Container Platform 클러스터의 작업자 시스템입니다. 노드는 VM(가상 머신) 또는 물리적 머신입니다.

- OAuth 클라이언트

- OAuth 클라이언트는 전달자 토큰을 얻는 데 사용됩니다.

- OAuth 서버

- OpenShift Container Platform 컨트롤 플레인에는 구성된 ID 공급자의 사용자 ID를 결정하고 액세스 토큰을 생성하는 기본 제공 OAuth 서버가 포함되어 있습니다.

- OpenID Connect

- OpenID Connect는 사용자가 SSO(Single Sign-On)를 사용하여 OpenID 공급자를 사용하는 사이트에 액세스하도록 사용자를 인증하는 프로토콜입니다.

- Passthrough 모드

- Passthrough 모드에서 CCO(Cloud Credential Operator)는 제공된 클라우드 인증 정보를 클라우드 인증 정보를 요청하는 구성 요소에 전달합니다.

- Pod

- Pod는 Kubernetes에서 가장 작은 논리 단위입니다. Pod는 작업자 노드에서 실행할 하나 이상의 컨테이너로 구성됩니다.

- Regular users

- 처음 로그인하거나 API를 통해 클러스터에서 자동으로 생성되는 사용자입니다.

- 요청 헤더

- 요청 헤더는 HTTP 요청 컨텍스트에 대한 정보를 제공하는 데 사용되는 HTTP 헤더이므로 서버가 요청의 응답을 추적할 수 있습니다.

- RBAC(역할 기반 액세스 제어)

- 클러스터 사용자와 워크로드가 역할을 실행하는 데 필요한 리소스에만 액세스할 수 있도록 하는 주요 보안 제어입니다.

- 서비스 계정

- 서비스 계정은 클러스터 구성 요소 또는 애플리케이션에서 사용합니다.

- System users

- 클러스터가 설치될 때 자동으로 생성되는 사용자입니다.

- 사용자

- 사용자는 API에 요청할 수 있는 엔티티입니다.

1.2. OpenShift Container Platform의 인증 정보

OpenShift Container Platform 클러스터에 대한 액세스를 제어하기 위해 클러스터 관리자는 사용자 인증을 구성하고 승인된 사용자만 클러스터에 액세스하도록 할 수 있습니다.

OpenShift Container Platform 클러스터와 상호 작용하려면 먼저 OpenShift Container Platform API에 대해 인증해야 합니다. OpenShift Container Platform API에 대한 요청에 OAuth 액세스 토큰 또는 X.509 클라이언트 인증서 를 제공하여 인증할 수 있습니다.

유효한 액세스 토큰 또는 인증서가 없으면 요청이 인증되지 않으며 HTTP 401 오류가 발생합니다.

관리자는 다음 작업을 통해 인증을 구성할 수 있습니다.

- ID 공급자 구성: OpenShift Container Platform에서 지원되는 ID 공급자 를 정의하고 클러스터에 추가할 수 있습니다.

내부 OAuth 서버 구성: OpenShift Container Platform 컨트롤 플레인에는 구성된 ID 공급자의 사용자 ID를 결정하고 액세스 토큰을 생성하는 기본 제공 OAuth 서버가 포함되어 있습니다. 토큰 기간 및 비활성 타임아웃을 구성하고 내부 OAuth 서버 URL을 사용자 지정할 수 있습니다.

참고사용자는 소유한 OAuth 토큰을 보고 관리할 수 있습니다.

OAuth 클라이언트 등록: OpenShift Container Platform에는 몇 가지 기본 OAuth 클라이언트가 포함되어 있습니다. 추가 OAuth 클라이언트를 등록하고 구성할 수 있습니다.

참고사용자가 OAuth 토큰에 대한 요청을 보내면 토큰을 수신하고 사용하는 기본 또는 사용자 지정 OAuth 클라이언트를 지정해야 합니다.

- Cloud Credentials Operator 를 사용하여 클라우드 공급자 인증 정보 관리 : 클러스터 구성 요소는 클라우드 공급자 인증 정보를 사용하여 클러스터 관련 작업을 수행하는 데 필요한 권한을 얻습니다.

- 시스템 admin 사용자 가장: 시스템 admin 사용자를 가장하여 사용자에게 클러스터 관리자 권한을 부여할 수 있습니다.

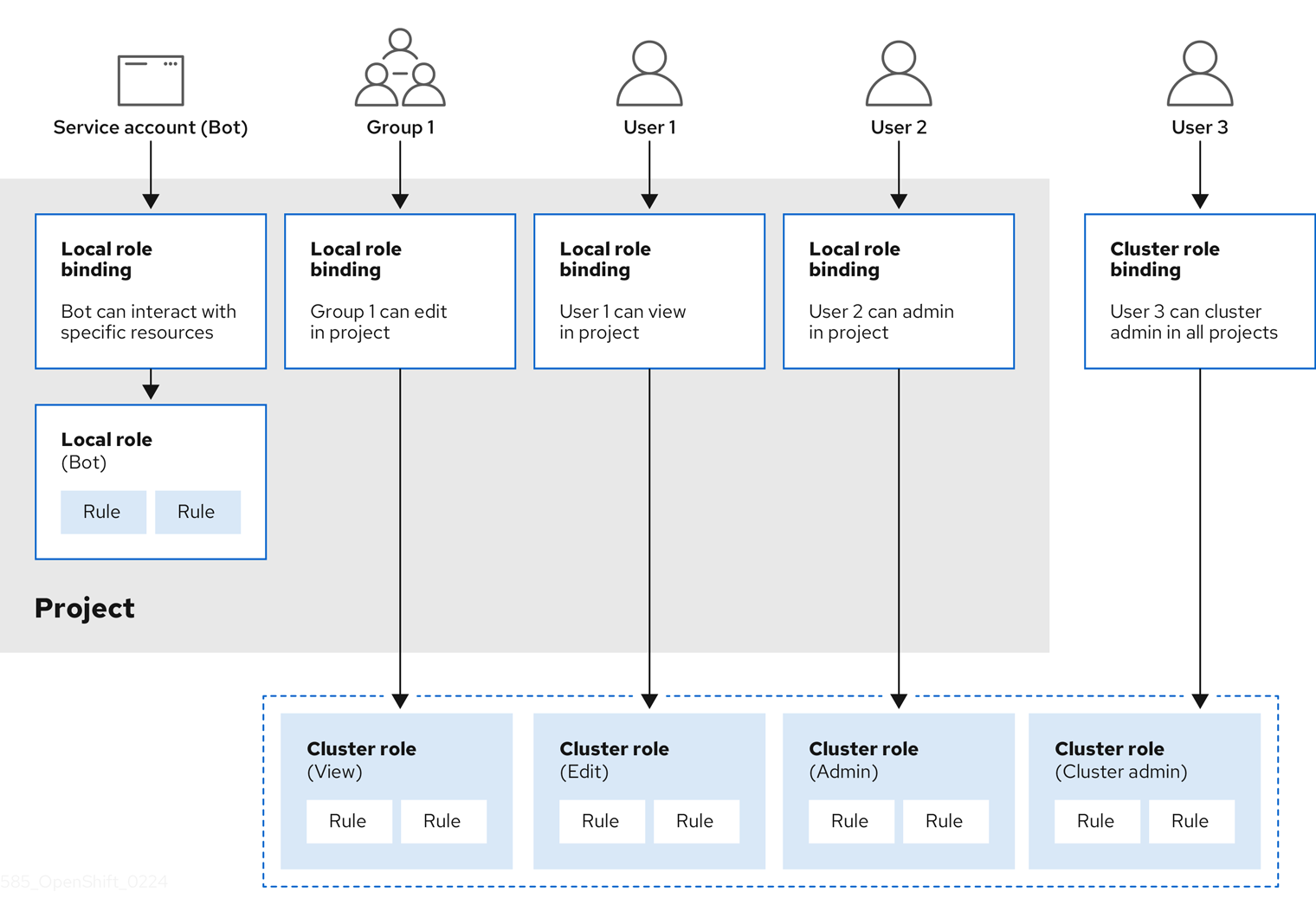

1.3. OpenShift Container Platform의 권한 부여 정보

권한 부여에는 확인된 사용자가 요청된 작업을 수행할 수 있는 권한이 있는지 여부를 확인하는 작업이 포함됩니다.

관리자는 권한을 정의하고 규칙, 역할, 바인딩과 같은 RBAC 오브젝트 를 사용하여 사용자에게 할당할 수 있습니다. OpenShift Container Platform에서 인증 작동 방식을 알아보려면 권한 부여 에스컬레이션을 참조하십시오.

프로젝트 및 네임스페이스 를 통해 OpenShift Container Platform 클러스터에 대한 액세스를 제어할 수도 있습니다.

클러스터에 대한 사용자 액세스 제어와 함께 Pod에서 수행할 수 있는 작업과 SCC(보안 컨텍스트 제약 조건) 를 사용하여 액세스할 수 있는 리소스를 제어할 수도 있습니다.

다음 작업을 통해 OpenShift Container Platform의 권한 부여를 관리할 수 있습니다.

- 로컬 및 클러스터 역할 및 바인딩을 확인합니다.

- 로컬 역할을 생성하고 사용자 또는 그룹에 할당합니다.

- 클러스터 역할을 생성하고 사용자 또는 그룹에 할당합니다. OpenShift Container Platform에는 기본 클러스터 역할 세트가 포함되어 있습니다. 추가 클러스터 역할을 생성하고 사용자 또는 그룹에 추가할 수 있습니다.

cluster-admin 사용자 생성: 기본적으로 클러스터에는

kubeadmin이라는 클러스터 관리자가 하나만 있습니다. 다른 클러스터 관리자를 생성할 수 있습니다. 클러스터 관리자를 생성하기 전에 ID 공급자를 구성했는지 확인합니다.참고클러스터 admin 사용자를 생성한 후 기존 kubeadmin 사용자를 삭제하여 클러스터 보안을 개선합니다.

- 서비스 계정 생성: 서비스 계정은 일반 사용자의 자격 증명을 공유하지 않고도 API 액세스를 유연하게 제어할 수 있는 방법을 제공합니다. 사용자는 애플리케이션에서 서비스 계정을 생성하고 OAuth 클라이언트로 사용할 수 있습니다.

- 범위 지정 토큰: 범위가 지정된 토큰은 특정 작업만 수행할 수 있는 특정 사용자로 식별하는 토큰입니다. 범위가 지정된 토큰을 생성하여 일부 권한을 다른 사용자 또는 서비스 계정에 위임할 수 있습니다.

- LDAP 그룹 동기화: LDAP 서버에 저장된 그룹을 OpenShift Container Platform 사용자 그룹과 동기화 하여 한 곳에서 사용자 그룹을 관리할 수 있습니다.

2장. 인증 이해

OpenShift Container Platform과 상호 작용하려는 사용자는 먼저 클러스터에 인증해야 합니다. 그러면 인증 계층에서 OpenShift Container Platform API에 대한 요청과 관련된 사용자를 확인합니다. 그런 다음 권한 부여 계층에서 요청한 사용자에 대한 정보로 요청의 허용 여부를 결정합니다.

관리자는 OpenShift Container Platform에 대한 인증을 구성할 수 있습니다.

2.1. 사용자

OpenShift Container Platform에서 사용자는 OpenShift Container Platform API에 요청할 수 있는 엔티티입니다. OpenShift Container Platform User 오브젝트는 행위자를 나타냅니다. 이 행위자에는 시스템에서 행위자 또는 행위자 그룹에 역할을 추가하여 권한을 부여할 수 있습니다. 일반적으로 OpenShift Container Platform과 상호 작용하는 개발자 또는 관리자 계정을 의미합니다.

다음과 같이 여러 유형의 사용자가 존재할 수 있습니다.

| 사용자 유형 | 설명 |

|---|---|

|

|

상호 작용을 가장 많이 하는 OpenShift Container Platform 사용자입니다. 일반 사용자는 처음 로그인할 때 시스템에서 자동으로 생성되며 API를 통해 생성할 수도 있습니다. 일반 사용자는 |

|

|

대부분의 시스템 사용자는 주로 인프라와 API 간의 안전한 상호 작용을 목적으로 인프라가 정의될 때 자동으로 생성됩니다. 여기에는 클러스터 관리자(전체 액세스 권한 보유), 노드별 사용자, 라우터 및 레지스트리용 사용자를 비롯하여 기타 다양한 사용자가 포함됩니다. 마지막으로, 인증되지 않은 요청에 기본적으로 사용되는 |

|

|

프로젝트와 관련된 특수한 시스템 사용자입니다. 일부는 프로젝트가 처음 생성될 때 자동으로 생성되지만 프로젝트 관리자가 각 프로젝트 콘텐츠에 대한 액세스 권한을 정의하기 위해 추가로 생성할 수도 있습니다. 서비스 계정은 |

각 사용자가 OpenShift Container Platform에 액세스하려면 어떠한 방식으로든 인증해야 합니다. 인증되지 않았거나 인증이 유효하지 않은 API 요청은 anonymous 시스템 사용자의 요청으로 인증됩니다. 인증 후 정책에 따라 사용자가 수행할 수 있는 작업이 결정됩니다.

2.2. 그룹

사용자는 하나 이상의 그룹에 할당될 수 있으며, 각 그룹은 특정 사용자 집합을 나타냅니다. 그룹은 권한 부여 정책을 관리하여 여러 사용자에게 한꺼번에 권한을 부여할 때 유용합니다(예: 사용자에게 개별적으로 오브젝트 액세스 권한을 부여하는 대신 특정 프로젝트 내의 여러 오브젝트에 대한 액세스 허용).

명시적으로 정의된 그룹 외에도 클러스터에서 자동으로 프로비저닝하는 시스템 그룹 또는 가상 그룹이 있습니다.

다음과 같은 기본 가상 그룹이 가장 중요합니다.

| 가상 그룹 | 설명 |

|---|---|

|

| 인증된 모든 사용자와 자동으로 연결됩니다. |

|

| OAuth 액세스 토큰을 사용하여 인증된 모든 사용자와 자동으로 연결됩니다. |

|

| 인증되지 않은 모든 사용자와 자동으로 연결됩니다. |

2.3. API 인증

OpenShift Container Platform API에 대한 요청은 다음과 같은 방법으로 인증됩니다.

- OAuth 액세스 토큰

-

<namespace_route>/oauth/authorize및<namespace_route>/oauth/token끝점을 사용하여 OpenShift Container Platform OAuth 서버에서 가져옵니다. -

Authorization: Bearer…헤더로 전송됩니다. -

WebSocket 요청의 경우

base64url.bearer.authorization.k8s.io.<base64url-encoded-token>형식의 WebSocket 하위 프로토콜 헤더로 전송됩니다.

-

- X.509 클라이언트 인증서

- API 서버에 대한 HTTPS 연결이 필요합니다.

- 신뢰할 수 있는 인증 기관 번들과 대조하여 API 서버에서 확인합니다.

- API 서버는 인증서를 작성하고 컨트롤러에 분배하여 자체적으로 인증합니다.

유효하지 않은 액세스 토큰 또는 유효하지 않은 인증서가 있는 요청은 401 오류와 함께 인증 계층에서 거부됩니다.

액세스 토큰이나 인증서가 없는 경우 인증 계층은 system:anonymous 가상 사용자 및 system:unauthenticated 가상 그룹을 요청에 할당합니다. 그러면 권한 부여 계층에서 익명 사용자가 할 수 있는 요청(있는 경우)을 결정합니다.

2.3.1. OpenShift Container Platform OAuth 서버

OpenShift Container Platform 마스터에는 내장 OAuth 서버가 포함되어 있습니다. 사용자는 API 인증을 위해 OAuth 액세스 토큰을 가져옵니다.

사용자가 새 OAuth 토큰을 요청하면 OAuth 서버는 구성된 ID 공급자를 사용하여 요청한 사람의 ID를 확인합니다.

그런 다음 해당 ID와 매핑되는 사용자를 결정하고 그 사용자를 위한 액세스 토큰을 만들어 제공합니다.

2.3.1.1. OAuth 토큰 요청

OAuth 토큰을 요청할 때마다 토큰을 받고 사용할 OAuth 클라이언트를 지정해야 합니다. OpenShift Container Platform API를 시작하면 다음 OAuth 클라이언트가 자동으로 생성됩니다.

| OAuth 클라이언트 | 사용법 |

|---|---|

|

|

대화형 로그인을 처리할 수 있는 사용자 에이전트를 사용하여 |

|

|

|

<namespace_route>는 네임스페이스 경로를 나타냅니다. 다음 명령을 실행하여 확인할 수 있습니다.$ oc get route oauth-openshift -n openshift-authentication -o json | jq .spec.host

OAuth 토큰에 대한 모든 요청에는 <namespace_route>/oauth/authorize에 대한 요청이 포함됩니다. 대부분의 인증 통합에서는 이 끝점 앞에 인증 프록시를 배치하거나 백업 ID 공급자에 대한 자격 증명의 유효성을 검사하도록 OpenShift Container Platform을 구성합니다. <namespace_route>/oauth/authorize에 대한 요청은 CLI와 같은 대화형 로그인 페이지를 표시할 수 없는 사용자 에이전트에서 발생할 수 있습니다. 따라서 OpenShift Container Platform은 대화형 로그인 flows 외에도 WWW-Authenticate 챌린지를 사용한 인증을 지원합니다.

인증 프록시를 <namespace_route>/oauth/authorize 끝점 앞에 배치하면 대화형 로그인 페이지를 표시하거나 대화형 로그인 flows로 리디렉션하는 대신 인증되지 않은 브라우저 이외의 사용자 에이전트 WWW-Authenticate 챌린지를 보냅니다.

브라우저 클라이언트에 대한 CSRF(Cross-Site Request Forgery) 공격을 방지하려면 X-CSRF-Token 헤더가 요청에 있는 경우에만 기본 인증 챌린지를 보냅니다. 기본 WWW-Authenticate 챌린지를 받을 것으로 예상되는 클라이언트는 이 헤더를 비어 있지 않은 값으로 설정해야 합니다.

인증 프록시가 WWW-Authenticate 챌린지를 지원할 수 없거나 OpenShift Container Platform이 WWW-Authenticate 챌린지를 지원하지 않는 ID 공급자를 사용하도록 구성된 경우, 브라우저를 사용하여 <namespace_route>/oauth/token/request에서 수동으로 토큰을 가져와야 합니다.

2.3.1.2. API 가장

OpenShift Container Platform API에 대한 요청을 다른 사용자가 보낸 것처럼 작동하도록 구성할 수 있습니다. 자세한 내용은 쿠버네티스 설명서의 사용자 가장을 참조하십시오.

2.3.1.3. Prometheus의 인증 지표

OpenShift Container Platform은 인증 시도 중 다음과 같은 Prometheus 시스템 지표를 캡처합니다.

-

openshift_auth_basic_password_count는oc login사용자 이름 및 암호 시도 횟수를 계산합니다. -

openshift_auth_basic_password_count_result는oc login사용자 이름 및 암호 시도 횟수를 결과,success또는error별로 계산합니다. -

openshift_auth_form_password_count는 웹 콘솔 로그인 시도 횟수를 계산합니다. -

openshift_auth_form_password_count_result는 웹 콘솔 로그인 시도 횟수를success또는error등 결과별로 계산합니다. -

openshift_auth_password_total은 총oc login및 웹 콘솔 로그인 시도 횟수를 계산합니다.

3장. 내부 OAuth 서버 구성

3.1. OpenShift Container Platform OAuth 서버

OpenShift Container Platform 마스터에는 내장 OAuth 서버가 포함되어 있습니다. 사용자는 API 인증을 위해 OAuth 액세스 토큰을 가져옵니다.

사용자가 새 OAuth 토큰을 요청하면 OAuth 서버는 구성된 ID 공급자를 사용하여 요청한 사람의 ID를 확인합니다.

그런 다음 해당 ID와 매핑되는 사용자를 결정하고 그 사용자를 위한 액세스 토큰을 만들어 제공합니다.

3.2. OAuth 토큰 요청 flows 및 응답

OAuth 서버는 표준 인증 코드 부여 및 암시적 부여 OAuth 인증 flows를 지원합니다.

WWW-Authenticate challenges (예: openshift-challenging-client)를 요청하기 위해 구성된 client_id와 함께 암시적 부여 flow(response_type=token)를 사용하여 OAuth 토큰을 요청하는 경우, /oauth/authorize에서 제공 가능한 서버 응답 및 처리 방법은 다음과 같습니다.

| 상태 | 내용 | 클라이언트 응답 |

|---|---|---|

| 302 |

URL 조각에 |

|

| 302 |

|

실패, |

| 302 |

기타 | 리디렉션을 따르고 해당 규칙을 사용하여 결과를 처리하십시오. |

| 401 |

|

유형이 인식되면(예: |

| 401 |

| 인증할 수 있는 챌린지가 없습니다. 실패했으며 응답 본문(OAuth 토큰을 가져올 수 있는 링크 및 대체 방법에 대한 세부 사항이 포함될 수 있음)을 표시합니다. |

| 기타 | 기타 | 실패, 사용자에게 응답 본문을 선택적으로 표시합니다. |

3.3. 내부 OAuth 서버 옵션

내부 OAuth 서버에는 다양한 구성 옵션을 사용할 수 있습니다.

3.3.1. OAuth 토큰 기간 옵션

내부 OAuth 서버는 두 종류의 토큰을 생성합니다.

| 토큰 | 설명 |

|---|---|

| 액세스 토큰 | API에 대한 액세스 권한을 부여하는 장기 토큰입니다. |

| 코드 인증 | 액세스 토큰으로 교환하는 용도로만 사용하는 단기 토큰입니다. |

두 가지 토큰 모두에 대해 기본 기간을 구성할 수 있습니다. 필요한 경우 OAuthClient 오브젝트 정의를 사용하여 액세스 토큰 지속 기간을 덮어쓸 수 있습니다.

3.3.2. OAuth 부여 옵션

OAuth 서버에서 사용자가 이전에 권한을 부여하지 않은 클라이언트에 대한 토큰 요청을 수신하는 경우, OAuth 서버에서 수행하는 조치는 OAuth 클라이언트의 권한 부여 전략에 따라 결정됩니다.

토큰을 요청하는 OAuth 클라이언트는 고유의 부여 전략을 제공해야 합니다.

다음과 같은 기본 방법을 적용할 수 있습니다.

| 부여 옵션 | 설명 |

|---|---|

|

| 부여를 자동 승인하고 요청을 다시 시도합니다. |

|

| 사용자에게 부여를 승인하거나 거부하도록 요청합니다. |

3.4. 내부 OAuth 서버의 토큰 기간 구성

내부 OAuth 서버의 토큰 기간에 대한 기본 옵션을 구성할 수 있습니다.

기본적으로 토큰은 24시간 동안만 유효합니다. 이 시간이 지나면 기존 세션이 만료됩니다.

기본 시간이 충분하지 않으면 다음 절차를 사용하여 수정할 수 있습니다.

절차

토큰 기간 옵션이 포함된 구성 파일을 만듭니다. 다음 파일에서는 이 값을 기본값의 두 배인 48시간으로 설정합니다.

apiVersion: config.openshift.io/v1 kind: OAuth metadata: name: cluster spec: tokenConfig: accessTokenMaxAgeSeconds: 172800 1- 1

- 액세스 토큰의 수명을 제어하려면

accessTokenMaxAgeSeconds를 설정하십시오. 기본 수명은 24시간 또는 86400초입니다. 이 속성은 음수일 수 없습니다. 0으로 설정하면 기본 라이프사이클이 사용됩니다.

새 구성 파일을 적용합니다.

참고기존 OAuth 서버를 업데이트하므로

oc apply명령을 사용하여 변경 사항을 적용해야 합니다.$ oc apply -f </path/to/file.yaml>

변경 사항이 적용되는지 확인합니다.

$ oc describe oauth.config.openshift.io/cluster

출력 예

... Spec: Token Config: Access Token Max Age Seconds: 172800 ...

3.5. 내부 OAuth 서버에 대한 토큰 비활성 타임아웃 구성

설정된 비활성 기간 후에 만료되도록 OAuth 토큰을 구성할 수 있습니다. 기본적으로 토큰 비활성 타임아웃은 설정되어 있지 않습니다.

토큰 비활성 타임아웃이 OAuth 클라이언트에도 구성된 경우 해당 값은 내부 OAuth 서버 구성에 설정된 타임아웃을 덮어씁니다.

사전 요구 사항

-

cluster-admin역할의 사용자로 클러스터에 액세스할 수 있습니다. - IDP(ID 공급자)를 구성했습니다.

절차

OAuth구성을 업데이트하여 토큰 비활성 타임아웃을 설정합니다.OAuth오브젝트를 편집합니다.$ oc edit oauth cluster

spec.tokenConfig.accessTokenInactivityTimeout필드를 추가하고 타임아웃 값을 설정합니다.apiVersion: config.openshift.io/v1 kind: OAuth metadata: ... spec: tokenConfig: accessTokenInactivityTimeout: 400s 1- 1

- 적절한 단위를 사용하여 값을 설정합니다(예: 400초는

400s, 30분은30m). 허용되는 최소 타임아웃 값은300s입니다.

- 파일을 저장하여 변경 사항을 적용합니다.

OAuth 서버 Pod가 다시 시작되었는지 확인합니다.

$ oc get clusteroperators authentication

다음 출력에 표시된 것처럼

PROGRESSING이False로 표시될 때까지 다음 단계를 진행하지 마십시오.출력 예

NAME VERSION AVAILABLE PROGRESSING DEGRADED SINCE authentication 4.12.0 True False False 145m

쿠버네티스 API 서버 pod의 새 버전이 출시되었는지 확인합니다. 이 작업에는 몇 분 정도 걸립니다.

$ oc get clusteroperators kube-apiserver

다음 출력에 표시된 것처럼

PROGRESSING이False로 표시될 때까지 다음 단계를 진행하지 마십시오.출력 예

NAME VERSION AVAILABLE PROGRESSING DEGRADED SINCE kube-apiserver 4.12.0 True False False 145m

PROGRESSING에True가 표시되면 몇 분 기다렸다가 다시 시도하십시오.

검증

- IDP의 ID로 클러스터에 로그인합니다.

- 명령을 실행하고 성공했는지 확인합니다.

- ID를 사용하지 않는 경우 구성된 타임아웃보다 대기 시간이 길어집니다. 이 절차의 예에서는 400초 이상 기다립니다.

동일한 ID의 세션에서 명령을 실행해 봅니다.

구성된 타임아웃보다 비활성 기간이 길어 토큰이 만료되므로 이 명령은 실패할 것입니다.

출력 예

error: You must be logged in to the server (Unauthorized)

3.6. 내부 OAuth 서버 URL 사용자 정의

클러스터 Ingress 구성의 spec.componentRoutes 필드에 사용자 정의 호스트 이름과 TLS 인증서를 설정하여 내부 OAuth 서버 URL을 사용자 지정할 수 있습니다.

내부 OAuth 서버 URL을 업데이트하는 경우 OAuth 액세스 토큰을 검색하기 위해 OpenShift OAuth 서버와 통신해야 하는 클러스터의 구성 요소에서 신뢰를 중단할 수 있습니다. OAuth 서버를 신뢰해야 하는 구성 요소는 OAuth 엔드포인트를 호출할 때 적절한 CA 번들을 포함해야 합니다. 예를 들면 다음과 같습니다.

$ oc login -u <username> -p <password> --certificate-authority=<path_to_ca.crt> 1- 1

- 자체 서명 인증서의 경우

ca.crt파일에 사용자 정의 CA 인증서가 포함되어야 합니다. 그렇지 않으면 로그인에 실패합니다.

Cluster Authentication Operator는 openshift-config-managed 네임스페이스의 oauth-serving-cert 구성 맵에 OAuth 서버의 제공 인증서를 게시합니다. 구성 맵의 data.ca-bundle.crt 키에서 인증서를 찾을 수 있습니다.

사전 요구 사항

- 관리 권한이 있는 사용자로 클러스터에 로그인했습니다.

TLS 인증서 및 키가 포함된

openshift-config네임스페이스에 시크릿을 생성했습니다. 사용자 지정 호스트 이름 접미사가 클러스터 도메인 접미사와 일치하지 않는 경우 이 작업이 필요합니다. 접미사가 일치하는 경우 시크릿은 선택 사항입니다.작은 정보oc create secret tls명령을 사용하여 TLS 시크릿을 생성할 수 있습니다.

절차

클러스터

Ingress구성을 편집합니다.$ oc edit ingress.config.openshift.io cluster

사용자 정의 호스트 이름과 서비스 인증서 및 키를 설정합니다.

apiVersion: config.openshift.io/v1 kind: Ingress metadata: name: cluster spec: componentRoutes: - name: oauth-openshift namespace: openshift-authentication hostname: <custom_hostname> 1 servingCertKeyPairSecret: name: <secret_name> 2- 파일을 저장하여 변경 사항을 적용합니다.

3.7. OAuth 서버 메타데이터

OpenShift Container Platform에서 실행되는 애플리케이션에서 내장 OAuth 서버에 대한 정보를 검색해야 할 수 있습니다. 예를 들어, 수동 구성이 없는 <namespace_route>의 주소를 찾아야 할 수도 있습니다. 이러한 작업을 지원하기 위해 OpenShift Container Platform에서는 IETF OAuth 2.0 인증 서버 메타데이터 초안 사양을 구현합니다.

따라서 클러스터 내에서 실행되는 모든 애플리케이션은 https://openshift.default.svc/.well-known/oauth-authorization-server에 GET 요청을 발행하여 다음 정보를 가져올 수 있습니다.

{

"issuer": "https://<namespace_route>", 1

"authorization_endpoint": "https://<namespace_route>/oauth/authorize", 2

"token_endpoint": "https://<namespace_route>/oauth/token", 3

"scopes_supported": [ 4

"user:full",

"user:info",

"user:check-access",

"user:list-scoped-projects",

"user:list-projects"

],

"response_types_supported": [ 5

"code",

"token"

],

"grant_types_supported": [ 6

"authorization_code",

"implicit"

],

"code_challenge_methods_supported": [ 7

"plain",

"S256"

]

}- 1

https체계를 사용하고 쿼리 또는 조각 구성 요소가 없는 URL에 해당하는 권한 부여 서버의 발행자 식별자. 권한 부여 서버에 대한 정보가 포함된.well-knownRFC 5785 리소스가 게시되는 위치입니다.- 2

- 권한 부여 서버의 권한 부여 끝점 URL. RFC 6749를 참조하십시오.

- 3

- 권한 서버의 토큰 Endpoint URL입니다. RFC 6749를 참조하십시오.

- 4

- 이 권한 부여 서버에서 지원하는 OAuth 2.0 RFC 6749 범위 값 목록이 포함된 JSON 배열. 지원되는 모든 범위 값이 제공되는 것은 아닙니다.

- 5

- 이 권한 부여 서버에서 지원하는 OAuth 2.0

response_type값 목록이 포함된 JSON 배열. 사용된 배열 값은 RFC 7591의 "OAuth 2.0 동적 클라이언트 등록 프로토콜"에서 정의한response_types매개변수에 사용된 것과 동일합니다. - 6

- 이 권한 부여 서버에서 지원하는 OAuth 2.0 부여 유형 값 목록이 포함된 JSON 배열. 사용된 배열 값은 RFC 7591의

OAuth 2.0 동적 클라이언트 등록 프로토콜에서 정의한grant_types매개변수에 사용된 것과 동일합니다. - 7

- 이 권한 부여 서버에서 지원하는 PKCE RFC 7636 코드 챌린지 방법 목록이 포함된 JSON 배열. 코드 챌린지 방법 값은 RFC 7636의 4.3절에 정의된

code_challenge_method매개변수에 사용됩니다. 유효한 코드 챌린지 방법 값은 IANAPKCE 코드 챌린지 방법레지스트리에 등록된 값입니다. IANA OAuth 매개변수를 참조하십시오.

3.8. OAuth API 이벤트 문제 해결

경우에 따라 API 서버는 API 마스터 로그에 직접 액세스하지 않고 디버그하기 어려운 예기치 않은 조건 오류 메시지를 반환합니다. 근본적인 오류 원인은 인증되지 않은 사용자에게 서버 상태에 대한 정보를 제공하지 않기 위해 의도적으로 숨겨져 있습니다.

이러한 오류 중 일부는 서비스 계정 OAuth 구성 문제와 관련이 있습니다. 이와 같은 문제는 관리자가 아닌 사용자가 볼 수 있는 이벤트에서 발견됩니다. OAuth 중에 unexpected condition 서버 오류가 발생하면 oc get events를 실행하여 ServiceAccount에서 해당 이벤트를 확인하십시오.

다음 예는 적절한 OAuth 리디렉션 URI가 없는 서비스 계정에 대해 경고합니다.

$ oc get events | grep ServiceAccount

출력 예

1m 1m 1 proxy ServiceAccount Warning NoSAOAuthRedirectURIs service-account-oauth-client-getter system:serviceaccount:myproject:proxy has no redirectURIs; set serviceaccounts.openshift.io/oauth-redirecturi.<some-value>=<redirect> or create a dynamic URI using serviceaccounts.openshift.io/oauth-redirectreference.<some-value>=<reference>

oc describe sa/<service_account_name>을 실행하면 지정된 서비스 계정 이름과 관련된 OAuth 이벤트가 보고됩니다.

$ oc describe sa/proxy | grep -A5 Events

출력 예

Events: FirstSeen LastSeen Count From SubObjectPath Type Reason Message --------- -------- ----- ---- ------------- -------- ------ ------- 3m 3m 1 service-account-oauth-client-getter Warning NoSAOAuthRedirectURIs system:serviceaccount:myproject:proxy has no redirectURIs; set serviceaccounts.openshift.io/oauth-redirecturi.<some-value>=<redirect> or create a dynamic URI using serviceaccounts.openshift.io/oauth-redirectreference.<some-value>=<reference>

다음은 가능한 이벤트 오류 목록입니다.

리디렉션 URI 주석이 없거나 유효하지 않은 URI가 지정되었습니다

Reason Message NoSAOAuthRedirectURIs system:serviceaccount:myproject:proxy has no redirectURIs; set serviceaccounts.openshift.io/oauth-redirecturi.<some-value>=<redirect> or create a dynamic URI using serviceaccounts.openshift.io/oauth-redirectreference.<some-value>=<reference>

잘못된 경로가 지정되었습니다

Reason Message NoSAOAuthRedirectURIs [routes.route.openshift.io "<name>" not found, system:serviceaccount:myproject:proxy has no redirectURIs; set serviceaccounts.openshift.io/oauth-redirecturi.<some-value>=<redirect> or create a dynamic URI using serviceaccounts.openshift.io/oauth-redirectreference.<some-value>=<reference>]

유효하지 않은 참조 유형이 지정되었습니다

Reason Message NoSAOAuthRedirectURIs [no kind "<name>" is registered for version "v1", system:serviceaccount:myproject:proxy has no redirectURIs; set serviceaccounts.openshift.io/oauth-redirecturi.<some-value>=<redirect> or create a dynamic URI using serviceaccounts.openshift.io/oauth-redirectreference.<some-value>=<reference>]

SA 토큰이 없습니다

Reason Message NoSAOAuthTokens system:serviceaccount:myproject:proxy has no tokens

4장. OAuth 클라이언트 구성

OpenShift Container Platform에서는 기본적으로 여러 OAuth 클라이언트가 생성됩니다. 추가 OAuth 클라이언트를 등록하고 구성할 수도 있습니다.

4.1. 기본 OAuth 클라이언트

OpenShift Container Platform API를 시작하면 다음 OAuth 클라이언트가 자동으로 생성됩니다.

| OAuth 클라이언트 | 사용법 |

|---|---|

|

|

대화형 로그인을 처리할 수 있는 사용자 에이전트를 사용하여 |

|

|

|

<namespace_route>는 네임스페이스 경로를 나타냅니다. 다음 명령을 실행하여 확인할 수 있습니다.$ oc get route oauth-openshift -n openshift-authentication -o json | jq .spec.host

4.2. 추가 OAuth 클라이언트 등록

OpenShift Container Platform 클러스터 인증을 관리하기 위해 추가 OAuth 클라이언트가 필요한 경우 하나의 클라이언트를 등록할 수 있습니다.

절차

추가 OAuth 클라이언트를 등록하려면 다음을 수행합니다.

$ oc create -f <(echo ' kind: OAuthClient apiVersion: oauth.openshift.io/v1 metadata: name: demo 1 secret: "..." 2 redirectURIs: - "http://www.example.com/" 3 grantMethod: prompt 4 ')

- 1

- OAuth 클라이언트의

name은<namespace_route>/oauth/authorize및<namespace_route>/oauth/token에 요청할 때client_id매개변수로 사용됩니다. - 2

secret은<namespace_route>/oauth/token에 요청할 때client_secret매개변수로 사용됩니다.- 3

<namespace_route>/oauth/authorize및<namespace_route>/oauth/token에 대한 요청에 지정된redirect_uri매개변수는redirectURIs매개변수 값에 나열된 URI 중 하나와 같거나 접두사로 지정되어야 합니다.- 4

grantMethod는 이 클라이언트에서 토큰을 요청할 때 사용자가 아직 액세스 권한을 부여받지 않은 경우 수행할 조치를 결정하는 데 사용됩니다. 부여를 자동으로 승인하고 요청을 다시 시도하려면auto를, 사용자에게 부여를 승인할지 또는 거부할지 묻는 메시지를 표시하려면prompt를 지정합니다.

4.3. OAuth 클라이언트에 대한 토큰 비활성 타임아웃 구성

설정된 비활성 기간이 지나면 OAuth 토큰이 만료되도록 OAuth 클라이언트를 구성할 수 있습니다. 기본적으로 토큰 비활성 타임아웃은 설정되어 있지 않습니다.

토큰 비활성 타임아웃이 내부 OAuth 서버 구성에도 구성된 경우 OAuth 클라이언트에 설정된 타임아웃이 해당 값을 덮어씁니다.

사전 요구 사항

-

cluster-admin역할의 사용자로 클러스터에 액세스할 수 있습니다. - IDP(ID 공급자)를 구성했습니다.

절차

OAuthClient구성을 업데이트하여 토큰 비활성 타임아웃을 설정합니다.OAuthClient오브젝트를 편집합니다.$ oc edit oauthclient <oauth_client> 1- 1

<oauth_client>를 구성할 OAuth 클라이언트(예:console)로 교체합니다.

accessTokenInactivityTimeoutSeconds필드를 추가하고 타임아웃 값을 설정합니다.apiVersion: oauth.openshift.io/v1 grantMethod: auto kind: OAuthClient metadata: ... accessTokenInactivityTimeoutSeconds: 600 1- 1

- 허용되는 최소 타임아웃 값(초)은

300입니다.

- 파일을 저장하여 변경 사항을 적용합니다.

검증

- IDP의 ID로 클러스터에 로그인합니다. 방금 구성한 OAuth 클라이언트를 사용해야 합니다.

- 조치를 수행하고 성공했는지 확인합니다.

- ID를 사용하지 않는 경우 구성된 타임아웃보다 대기 시간이 길어집니다. 이 절차의 예에서는 600초 이상 기다립니다.

동일한 ID의 세션에서 작업을 수행해 보십시오.

구성된 타임아웃보다 비활성 기간이 길어 토큰이 만료되므로 이 시도는 실패할 것입니다.

4.4. 추가 리소스

5장. 사용자 소유 OAuth 액세스 토큰 관리

사용자는 자체 OAuth 액세스 토큰을 검토하고 더 이상 필요하지 않은 항목을 삭제할 수 있습니다.

5.1. 사용자 소유 OAuth 액세스 토큰 나열

사용자 소유 OAuth 액세스 토큰을 나열할 수 있습니다. 토큰 이름은 민감하지 않으며 로그인에 사용할 수 없습니다.

절차

모든 사용자 소유 OAuth 액세스 토큰 나열:

$ oc get useroauthaccesstokens

출력 예

NAME CLIENT NAME CREATED EXPIRES REDIRECT URI SCOPES <token1> openshift-challenging-client 2021-01-11T19:25:35Z 2021-01-12 19:25:35 +0000 UTC https://oauth-openshift.apps.example.com/oauth/token/implicit user:full <token2> openshift-browser-client 2021-01-11T19:27:06Z 2021-01-12 19:27:06 +0000 UTC https://oauth-openshift.apps.example.com/oauth/token/display user:full <token3> console 2021-01-11T19:26:29Z 2021-01-12 19:26:29 +0000 UTC https://console-openshift-console.apps.example.com/auth/callback user:full

특정 OAuth 클라이언트의 사용자 소유자 OAuth 액세스 토큰 나열:

$ oc get useroauthaccesstokens --field-selector=clientName="console"

출력 예

NAME CLIENT NAME CREATED EXPIRES REDIRECT URI SCOPES <token3> console 2021-01-11T19:26:29Z 2021-01-12 19:26:29 +0000 UTC https://console-openshift-console.apps.example.com/auth/callback user:full

5.2. 사용자 소유 OAuth 액세스 토큰의 세부 정보 보기

사용자 소유 OAuth 액세스 토큰의 세부 정보를 볼 수 있습니다.

절차

사용자 소유 OAuth 액세스 토큰의 세부 정보 설명:

$ oc describe useroauthaccesstokens <token_name>

출력 예

Name: <token_name> 1 Namespace: Labels: <none> Annotations: <none> API Version: oauth.openshift.io/v1 Authorize Token: sha256~Ksckkug-9Fg_RWn_AUysPoIg-_HqmFI9zUL_CgD8wr8 Client Name: openshift-browser-client 2 Expires In: 86400 3 Inactivity Timeout Seconds: 317 4 Kind: UserOAuthAccessToken Metadata: Creation Timestamp: 2021-01-11T19:27:06Z Managed Fields: API Version: oauth.openshift.io/v1 Fields Type: FieldsV1 fieldsV1: f:authorizeToken: f:clientName: f:expiresIn: f:redirectURI: f:scopes: f:userName: f:userUID: Manager: oauth-server Operation: Update Time: 2021-01-11T19:27:06Z Resource Version: 30535 Self Link: /apis/oauth.openshift.io/v1/useroauthaccesstokens/<token_name> UID: f9d00b67-ab65-489b-8080-e427fa3c6181 Redirect URI: https://oauth-openshift.apps.example.com/oauth/token/display Scopes: user:full 5 User Name: <user_name> 6 User UID: 82356ab0-95f9-4fb3-9bc0-10f1d6a6a345 Events: <none>

5.3. 사용자 소유 OAuth 액세스 토큰 삭제

oc logout 명령은 활성 세션에 대해 OAuth 토큰만 무효화합니다. 다음 절차에 따라 더 이상 필요하지 않은 사용자 소유 OAuth 토큰을 삭제할 수 있습니다.

OAuth 액세스 토큰을 삭제하면 토큰을 사용하는 모든 세션에서 사용자를 로그아웃합니다.

절차

사용자 소유 OAuth 액세스 토큰 삭제:

$ oc delete useroauthaccesstokens <token_name>

출력 예

useroauthaccesstoken.oauth.openshift.io "<token_name>" deleted

6장. ID 공급자 구성 이해

OpenShift Container Platform 마스터에는 내장 OAuth 서버가 포함되어 있습니다. 개발자와 관리자는 OAuth 액세스 토큰을 가져와 API 인증을 수행합니다.

관리자는 클러스터를 설치한 후 ID 공급자를 지정하도록 OAuth를 구성할 수 있습니다.

6.1. OpenShift Container Platform의 ID 공급자 정보

기본적으로는 kubeadmin 사용자만 클러스터에 있습니다. ID 공급자를 지정하려면 해당 ID 공급자를 설명하는 CR(사용자 정의 리소스)을 생성하여 클러스터에 추가해야 합니다.

/, :, %를 포함하는 OpenShift Container Platform 사용자 이름은 지원되지 않습니다.

6.2. 지원되는 ID 공급자

다음 유형의 ID 공급자를 구성할 수 있습니다.

| ID 공급자 | 설명 |

|---|---|

|

| |

|

내부 데이터베이스에 사용자를 저장하는 OpenStack Keystone v3 서버와의 공유 인증을 지원하기 위해 OpenShift Container Platform 클러스터를 Keystone과 통합하도록 | |

|

단순 바인드 인증을 사용하여 LDAPv3 서버에 대해 사용자 이름 및 암호의 유효성을 확인하도록 | |

|

사용자가 원격 ID 공급자에 대해 검증된 자격 증명을 사용하여 OpenShift Container Platform에 로그인할 수 있도록 | |

|

| |

|

GitHub 또는 GitHub Enterprise의 OAuth 인증 서버에 대해 사용자 이름 및 암호의 유효성을 확인하도록 | |

|

GitLab.com 또는 기타 GitLab 인스턴스를 ID 공급자로 사용하도록 | |

|

Google의 OpenID Connect 통합을 사용하여 | |

|

인증 코드 Flow를 사용하여 OpenID Connect ID 공급자와 통합하도록 |

ID 공급자를 정의하면 RBAC를 사용하여 권한을 정의하고 적용할 수 있습니다.

6.3. kubeadmin 사용자 제거

ID 공급자를 정의하고 새 cluster-admin 사용자를 만든 다음 kubeadmin을 제거하여 클러스터 보안을 강화할 수 있습니다.

다른 사용자가 cluster-admin이 되기 전에 이 절차를 수행하는 경우 OpenShift Container Platform을 다시 설치해야 합니다. 이 명령은 취소할 수 없습니다.

사전 요구 사항

- 하나 이상의 ID 공급자를 구성해야 합니다.

-

사용자에게

cluster-admin역할을 추가해야 합니다. - 관리자로 로그인해야 합니다.

절차

kubeadmin시크릿을 제거합니다.$ oc delete secrets kubeadmin -n kube-system

6.4. ID 공급자 매개변수

다음 매개변수는 모든 ID 공급자에 공통입니다.

| 매개변수 | 설명 |

|---|---|

|

| 공급자 사용자 이름에 접두어로 공급자 이름을 지정하여 ID 이름을 만듭니다. |

|

| 사용자가 로그인할 때 새 ID를 사용자에게 매핑하는 방법을 정의합니다. 다음 값 중 하나를 입력하십시오.

|

ID 공급자를 추가하거나 변경할 때 mappingMethod 매개변수를 add로 설정하면 새 공급자의 ID를 기존 사용자에게 매핑할 수 있습니다.

6.5. ID 공급자 CR 샘플

다음 CR(사용자 정의 리소스)에서는 ID 공급자를 구성하는 데 사용되는 매개변수 및 기본값을 보여줍니다. 이 예에서는 htpasswd ID 공급자를 사용합니다.

ID 공급자 CR 샘플

apiVersion: config.openshift.io/v1 kind: OAuth metadata: name: cluster spec: identityProviders: - name: my_identity_provider 1 mappingMethod: claim 2 type: HTPasswd htpasswd: fileData: name: htpass-secret 3

7장. ID 공급자 구성

7.1. htpasswd ID 공급자 구성

htpasswd ID 공급자를 구성하여 사용자가 htpasswd 파일에서 인증 정보를 사용하여 OpenShift Container Platform에 로그인할 수 있도록 합니다.

htpasswd ID 공급자를 정의하려면 다음 작업을 수행합니다.

-

htpasswd파일을 생성하여 사용자 및 암호 정보를 저장합니다. -

htpasswd파일을 나타내는 시크릿을 생성합니다. - 시크릿 을 참조하는 htpasswd ID 공급자 리소스를 정의합니다.

- 리소스를 기본 OAuth 구성에 적용하여 ID 공급자를 추가합니다.

7.1.1. OpenShift Container Platform의 ID 공급자 정보

기본적으로는 kubeadmin 사용자만 클러스터에 있습니다. ID 공급자를 지정하려면 해당 ID 공급자를 설명하는 CR(사용자 정의 리소스)을 생성하여 클러스터에 추가해야 합니다.

/, :, %를 포함하는 OpenShift Container Platform 사용자 이름은 지원되지 않습니다.

7.1.2. htpasswd 인증 정보

OpenShift Container Platform에서 htpasswd 인증을 사용하면 htpasswd 파일을 기반으로 사용자를 식별할 수 있습니다. htpasswd 파일은 각 사용자의 사용자 이름과 해시된 암호를 포함하는 플랫 파일입니다. htpasswd 유틸리티를 사용하여 이 파일을 생성할 수 있습니다.

7.1.3. htpasswd 파일 생성

htpasswd 파일을 생성하는 방법에 대한 지침은 다음 섹션 중 하나를 참조하십시오.

7.1.3.1. Linux를 사용하여 htpasswd 파일 생성

htpasswd ID 공급자를 사용하려면 htpasswd 를 사용하여 클러스터의 사용자 이름 및 암호가 포함된 플랫 파일을 생성해야 합니다.

사전 요구 사항

-

htpasswd유틸리티에 액세스할 수 있습니다. Red Hat Enterprise Linux에서는httpd-tools패키지를 설치하면 액세스할 수 있습니다.

절차

사용자 이름과 해시된 암호로 플랫 파일을 생성하거나 업데이트합니다.

$ htpasswd -c -B -b </path/to/users.htpasswd> <username> <password>

이 명령에서는 해시된 버전의 암호를 생성합니다.

예를 들면 다음과 같습니다.

$ htpasswd -c -B -b users.htpasswd <username> <password>

출력 예

Adding password for user user1

인증 정보를 파일에 계속 추가하거나 업데이트합니다.

$ htpasswd -B -b </path/to/users.htpasswd> <user_name> <password>

7.1.3.2. Windows를 사용하여 htpasswd 파일 생성

htpasswd ID 공급자를 사용하려면 htpasswd 를 사용하여 클러스터의 사용자 이름 및 암호가 포함된 플랫 파일을 생성해야 합니다.

사전 요구 사항

-

htpasswd.exe에 액세스할 수 있습니다. 이 파일은 많은 Apache httpd 배포판의\bin디렉터리에 포함되어 있습니다.

절차

사용자 이름과 해시된 암호로 플랫 파일을 생성하거나 업데이트합니다.

> htpasswd.exe -c -B -b <\path\to\users.htpasswd> <username> <password>

이 명령에서는 해시된 버전의 암호를 생성합니다.

예를 들면 다음과 같습니다.

> htpasswd.exe -c -B -b users.htpasswd <username> <password>

출력 예

Adding password for user user1

인증 정보를 파일에 계속 추가하거나 업데이트합니다.

> htpasswd.exe -b <\path\to\users.htpasswd> <username> <password>

7.1.4. htpasswd 시크릿 생성

htpasswd ID 공급자를 사용하려면 htpasswd 사용자 파일이 포함된 시크릿을 정의해야 합니다.

사전 요구 사항

- htpasswd 파일을 생성합니다.

절차

htpasswd 사용자 파일이 포함된

Secret오브젝트를 생성합니다.$ oc create secret generic htpass-secret --from-file=htpasswd=<path_to_users.htpasswd> -n openshift-config 1- 1

--from-file인수에 대한 사용자 파일이 포함된 보안 키의 이름은 위의 명령과 같이htpasswd로 지정해야 합니다.

작은 정보다음 YAML을 적용하여 시크릿을 생성할 수도 있습니다.

apiVersion: v1 kind: Secret metadata: name: htpass-secret namespace: openshift-config type: Opaque data: htpasswd: <base64_encoded_htpasswd_file_contents>

7.1.5. htpasswd CR 샘플

다음 CR(사용자 정의 리소스)에는 htpasswd ID 공급자에 대한 매개변수 및 허용 가능한 값이 표시되어 있습니다.

htpasswd CR

apiVersion: config.openshift.io/v1 kind: OAuth metadata: name: cluster spec: identityProviders: - name: my_htpasswd_provider 1 mappingMethod: claim 2 type: HTPasswd htpasswd: fileData: name: htpass-secret 3

추가 리소스

-

모든 ID 공급자에 공통된

mappingMethod와 같은 매개변수에 대한 자세한 내용은 ID 공급자 매개변수를 참조하십시오.

7.1.6. 클러스터에 ID 공급자 추가

클러스터를 설치한 후에는 사용자가 인증할 수 있도록 ID 공급자를 추가하십시오.

사전 요구 사항

- OpenShift Container Platform 클러스터를 생성합니다.

- ID 공급자의 CR(사용자 정의 리소스)을 만듭니다.

- 관리자로 로그인해야 합니다.

절차

정의된 CR을 적용합니다.

$ oc apply -f </path/to/CR>

참고CR이 존재하지 않는 경우

oc apply를 통해 새 CR을 생성하고 다음 경고를 트리거할 수 있습니다.Warning: oc apply should be used on resources created by either oc create --save-config or oc apply. 이 경우 이 경고를 무시해도 됩니다.암호를 입력하라는 메시지가 표시되면 암호를 입력하여 ID 공급자의 사용자로 클러스터에 로그인합니다.

$ oc login -u <username>

사용자가 로그인했는지 확인하고 사용자 이름을 표시합니다.

$ oc whoami

7.1.7. htpasswd ID 공급자의 사용자 업데이트

기존 htpasswd ID 공급자에서 사용자를 추가하거나 제거할 수 있습니다.

사전 요구 사항

-

htpasswd 사용자 파일이 포함된

Secret오브젝트를 생성했습니다. 이 절차에서는 이름을htpass-secret이라고 가정합니다. -

htpasswd ID 공급자를 구성했습니다. 이 절차에서는 이름이

my_htpasswd_provider라고 가정합니다. -

htpasswd유틸리티에 액세스할 수 있습니다. Red Hat Enterprise Linux에서는httpd-tools패키지를 설치하면 액세스할 수 있습니다. - 클러스터 관리자 권한이 있어야 합니다.

절차

htpass-secretSecret오브젝트에서 htpasswd 파일을 검색하여 파일 시스템에 저장합니다.$ oc get secret htpass-secret -ojsonpath={.data.htpasswd} -n openshift-config | base64 --decode > users.htpasswdusers.htpasswd파일에서 사용자를 추가하거나 제거합니다.새로운 사용자 추가:

$ htpasswd -bB users.htpasswd <username> <password>

출력 예

Adding password for user <username>

기존 사용자 제거:

$ htpasswd -D users.htpasswd <username>

출력 예

Deleting password for user <username>

users.htpasswd파일에서htpass-secretSecret오브젝트를 업데이트된 사용자로 교체합니다.$ oc create secret generic htpass-secret --from-file=htpasswd=users.htpasswd --dry-run=client -o yaml -n openshift-config | oc replace -f -

작은 정보다음 YAML을 적용하여 시크릿을 대체할 수 있습니다.

apiVersion: v1 kind: Secret metadata: name: htpass-secret namespace: openshift-config type: Opaque data: htpasswd: <base64_encoded_htpasswd_file_contents>

하나 이상의 사용자를 제거한 경우 각 사용자에 대한 기존 리소스를 추가로 제거해야 합니다.

User오브젝트 삭제:$ oc delete user <username>

출력 예

user.user.openshift.io "<username>" deleted

사용자를 제거해야 합니다. 그러지 않으면 토큰이 만료되지 않는 한 사용자가 토큰을 계속 사용할 수 있습니다.

사용자의

Identity오브젝트 삭제:$ oc delete identity my_htpasswd_provider:<username>

출력 예

identity.user.openshift.io "my_htpasswd_provider:<username>" deleted

7.1.8. 웹 콘솔을 사용하여 ID 공급자 구성

CLI 대신 웹 콘솔을 통해 ID 공급자(IDP)를 구성합니다.

사전 요구 사항

- 웹 콘솔에 클러스터 관리자로 로그인해야 합니다.

절차

- Administration → Cluster Settings으로 이동합니다.

- 구성 탭에서 OAuth 를 클릭합니다.

- ID 공급자 섹션의 추가 드롭다운 메뉴에서 ID 공급자를 선택합니다.

기존 IDP를 덮어쓰지 않고 웹 콘솔을 통해 여러 IDP를 지정할 수 있습니다.

7.2. Keystone ID 공급자 구성

내부 데이터베이스에 사용자를 저장하는 OpenStack Keystone v3 서버와의 공유 인증을 지원하기 위해 OpenShift Container Platform 클러스터를 Keystone과 통합하도록 keystone ID 공급자를 구성합니다. 이 구성을 통해 사용자는 Keystone 자격 증명을 사용하여 OpenShift Container Platform에 로그인할 수 있습니다.

7.2.1. OpenShift Container Platform의 ID 공급자 정보

기본적으로는 kubeadmin 사용자만 클러스터에 있습니다. ID 공급자를 지정하려면 해당 ID 공급자를 설명하는 CR(사용자 정의 리소스)을 생성하여 클러스터에 추가해야 합니다.

/, :, %를 포함하는 OpenShift Container Platform 사용자 이름은 지원되지 않습니다.

7.2.2. Keystone 인증 정보

Keystone은 ID, 토큰, 카탈로그 및 정책 서비스를 제공하는 OpenStack 프로젝트입니다.

새 OpenShift Container Platform 사용자가 Keystone 사용자 이름 또는 고유한 Keystone ID를 기반으로 하도록 Keystone과의 통합을 구성할 수 있습니다. 두 방법 모두 사용자는 Keystone 사용자 이름과 암호를 입력하여 로그인합니다. Keystone ID에서 OpenShift Container Platform 사용자를 배치하는 것은 Keystone 사용자를 삭제하고 해당 사용자 이름으로 새 Keystone 사용자를 만드는 경우 새 사용자가 이전 사용자의 리소스에 액세스할 수 있기 때문에 더 안전합니다.

7.2.3. 시크릿 생성

ID 공급자는 openshift-config 네임스페이스에서 OpenShift Container Platform Secret 오브젝트를 사용하여 클라이언트 시크릿, 클라이언트 인증서 및 키를 포함합니다.

절차

다음 명령을 사용하여 키 및 인증서가 포함된

Secret오브젝트를 생성합니다.$ oc create secret tls <secret_name> --key=key.pem --cert=cert.pem -n openshift-config

작은 정보다음 YAML을 적용하여 시크릿을 생성할 수도 있습니다.

apiVersion: v1 kind: Secret metadata: name: <secret_name> namespace: openshift-config type: kubernetes.io/tls data: tls.crt: <base64_encoded_cert> tls.key: <base64_encoded_key>

7.2.4. 구성 맵 생성

ID 공급자는 openshift-config 네임스페이스에서 OpenShift Container Platform ConfigMap 오브젝트를 사용하여 인증 기관 번들을 포함합니다. 이들은 주로 ID 공급자에 필요한 인증서 번들을 포함하는 데 사용됩니다.

절차

다음 명령을 사용하여 인증 기관을 포함하는 OpenShift Container Platform

ConfigMap오브젝트를 정의합니다. 인증 기관은ConfigMap오브젝트의ca.crt키에 저장해야 합니다.$ oc create configmap ca-config-map --from-file=ca.crt=/path/to/ca -n openshift-config

작은 정보다음 YAML을 적용하여 구성 맵을 만들 수 있습니다.

apiVersion: v1 kind: ConfigMap metadata: name: ca-config-map namespace: openshift-config data: ca.crt: | <CA_certificate_PEM>

7.2.5. Keystone CR 샘플

다음 CR(사용자 정의 리소스)에는 Keystone ID 공급자에 대한 매개변수 및 허용 가능한 값이 표시되어 있습니다.

Keystone CR

apiVersion: config.openshift.io/v1 kind: OAuth metadata: name: cluster spec: identityProviders: - name: keystoneidp 1 mappingMethod: claim 2 type: Keystone keystone: domainName: default 3 url: https://keystone.example.com:5000 4 ca: 5 name: ca-config-map tlsClientCert: 6 name: client-cert-secret tlsClientKey: 7 name: client-key-secret

- 1

- 이 공급자 이름은 공급자 사용자 이름에 접두어로 지정되어 ID 이름을 형성합니다.

- 2

- 이 공급자의 ID와

User오브젝트 간 매핑 설정 방법을 제어합니다. - 3

- Keystone 도메인 이름. Keystone에서는 사용자 이름이 도메인에 따라 다릅니다. 단일 도메인만 지원됩니다.

- 4

- Keystone 서버 연결에 사용하는 URL입니다(필수). https를 사용해야 합니다.

- 5

- 선택 사항: OpenShift Container Platform

ConfigMap오브젝트에 대한 참조로, 구성된 URL에 대한 서버 인증서의 유효성 확인에 사용할 PEM 인코딩 인증 기관 번들이 포함됩니다. - 6

- 선택 사항: OpenShift Container Platform

Secret오브젝트에 대한 참조로, 구성된 URL에 요청할 때 제공할 클라이언트 인증서가 포함됩니다. - 7

- OpenShift Container Platform

Secret오브젝트에 대한 참조로, 클라이언트 인증서에 대한 키가 포함됩니다.tlsClientCert가 지정된 경우 필수입니다.

추가 리소스

-

모든 ID 공급자에 공통된

mappingMethod와 같은 매개변수에 대한 자세한 내용은 ID 공급자 매개변수를 참조하십시오.

7.2.6. 클러스터에 ID 공급자 추가

클러스터를 설치한 후에는 사용자가 인증할 수 있도록 ID 공급자를 추가하십시오.

사전 요구 사항

- OpenShift Container Platform 클러스터를 생성합니다.

- ID 공급자의 CR(사용자 정의 리소스)을 만듭니다.

- 관리자로 로그인해야 합니다.

절차

정의된 CR을 적용합니다.

$ oc apply -f </path/to/CR>

참고CR이 존재하지 않는 경우

oc apply를 통해 새 CR을 생성하고 다음 경고를 트리거할 수 있습니다.Warning: oc apply should be used on resources created by either oc create --save-config or oc apply. 이 경우 이 경고를 무시해도 됩니다.암호를 입력하라는 메시지가 표시되면 암호를 입력하여 ID 공급자의 사용자로 클러스터에 로그인합니다.

$ oc login -u <username>

사용자가 로그인했는지 확인하고 사용자 이름을 표시합니다.

$ oc whoami

7.3. LDAP ID 공급자 구성

단순 바인드 인증을 사용하여 LDAPv3 서버에 대해 사용자 이름 및 암호의 유효성을 확인하도록 ldap ID 공급자를 구성합니다.

7.3.1. OpenShift Container Platform의 ID 공급자 정보

기본적으로는 kubeadmin 사용자만 클러스터에 있습니다. ID 공급자를 지정하려면 해당 ID 공급자를 설명하는 CR(사용자 정의 리소스)을 생성하여 클러스터에 추가해야 합니다.

/, :, %를 포함하는 OpenShift Container Platform 사용자 이름은 지원되지 않습니다.

7.3.2. LDAP 인증 정보

LDAP 디렉터리는 인증 중 제공된 사용자 이름과 일치하는 항목으로 검색됩니다. 고유한 일치 항목이 1개 발견되는 경우 해당 항목의 고유 이름(DN)과 제공된 암호를 사용하여 단순 바인딩이 시도됩니다.

다음 단계를 수행합니다.

-

구성된

URL의 속성 및 필터를 사용자가 입력한 사용자 이름과 결합하여 검색 필터를 생성합니다. - 생성된 필터를 사용하여 디렉터리를 검색합니다. 검색에서 정확히 하나의 항목을 반환하지 않으면 액세스를 거부합니다.

- 검색에서 검색된 항목의 DN과 사용자 제공 암호를 사용하여 LDAP 서버에 바인딩합니다.

- 바인딩에 실패하면 액세스를 거부합니다.

- 바인딩이 성공하면 구성된 속성을 ID, 이메일 주소, 표시 이름, 기본 사용자 이름으로 사용하여 ID를 빌드합니다.

구성된 URL은 RFC 2255 URL이며, 사용할 LDAP 호스트 및 검색 매개변수를 지정합니다. URL 구문은 다음과 같습니다.

ldap://host:port/basedn?attribute?scope?filter

이 URL의 경우

| URL 구성 요소 | 설명 |

|---|---|

|

|

일반 LDAP의 경우 |

|

|

LDAP 서버의 이름 및 포트입니다. ldap의 경우 기본값은 |

|

| 모든 검색을 시작해야 하는 디렉터리 분기의 DN입니다. 적어도 디렉터리 트리의 맨 위에 있어야 하지만 디렉터리에 하위 트리를 지정할 수도 있습니다. |

|

|

검색할 속성입니다. RFC 2255에서는 쉼표로 구분된 속성 목록을 사용할 수 있지만 제공되는 속성 수와 관계없이 첫 번째 속성만 사용됩니다. 속성이 제공되지 않는 경우 기본값은 |

|

|

검색 범위입니다. |

|

|

유효한 LDAP 검색 필터입니다. 제공하지 않는 경우 기본값은 |

검색을 수행할 때 속성, 필터, 제공된 사용자 이름을 결합하여 다음과 같은 검색 필터가 생성됩니다.

(&(<filter>)(<attribute>=<username>))

예를 들어 다음과 같은 URL을 살펴보십시오.

ldap://ldap.example.com/o=Acme?cn?sub?(enabled=true)

클라이언트가 사용자 이름 bob을 사용하여 연결을 시도하는 경우 결과 검색 필터는 (&(enabled=true)(cn=bob))입니다.

LDAP 디렉터리에서 검색에 인증이 필요한 경우 항목을 검색하는 데 사용할 bindDN 및 bindPassword를 지정하십시오.

7.3.3. LDAP 시크릿 생성

ID 공급자를 사용하려면 bindPassword 필드가 포함된 OpenShift Container Platform Secret 오브젝트를 정의해야 합니다.

절차

bindPassword필드가 포함된Secret오브젝트를 생성합니다.$ oc create secret generic ldap-secret --from-literal=bindPassword=<secret> -n openshift-config 1- 1

--from-literal인수에 대한 bindPassword를 포함하는 시크릿 키를bindPassword라고 해야 합니다.

작은 정보다음 YAML을 적용하여 시크릿을 생성할 수도 있습니다.

apiVersion: v1 kind: Secret metadata: name: ldap-secret namespace: openshift-config type: Opaque data: bindPassword: <base64_encoded_bind_password>

7.3.4. 구성 맵 생성

ID 공급자는 openshift-config 네임스페이스에서 OpenShift Container Platform ConfigMap 오브젝트를 사용하여 인증 기관 번들을 포함합니다. 이들은 주로 ID 공급자에 필요한 인증서 번들을 포함하는 데 사용됩니다.

절차

다음 명령을 사용하여 인증 기관을 포함하는 OpenShift Container Platform

ConfigMap오브젝트를 정의합니다. 인증 기관은ConfigMap오브젝트의ca.crt키에 저장해야 합니다.$ oc create configmap ca-config-map --from-file=ca.crt=/path/to/ca -n openshift-config

작은 정보다음 YAML을 적용하여 구성 맵을 만들 수 있습니다.

apiVersion: v1 kind: ConfigMap metadata: name: ca-config-map namespace: openshift-config data: ca.crt: | <CA_certificate_PEM>

7.3.5. LDAP CR 샘플

다음 CR(사용자 정의 리소스)에는 LDAP ID 공급자에 대한 매개변수 및 허용 가능한 값이 표시되어 있습니다.

LDAP CR

apiVersion: config.openshift.io/v1 kind: OAuth metadata: name: cluster spec: identityProviders: - name: ldapidp 1 mappingMethod: claim 2 type: LDAP ldap: attributes: id: 3 - dn email: 4 - mail name: 5 - cn preferredUsername: 6 - uid bindDN: "" 7 bindPassword: 8 name: ldap-secret ca: 9 name: ca-config-map insecure: false 10 url: "ldaps://ldaps.example.com/ou=users,dc=acme,dc=com?uid" 11

- 1

- 이 공급자 이름은 반환된 사용자 ID 앞에 접두어로 지정되어 ID 이름을 형성합니다.

- 2

- 이 공급자의 ID와

User오브젝트 간 매핑 설정 방법을 제어합니다. - 3

- ID로 사용할 속성 목록입니다. 비어 있지 않은 첫 번째 속성이 사용됩니다. 하나 이상의 속성이 필요합니다. 나열된 어떤 속성에도 값이 없는 경우 인증이 실패합니다. 정의된 속성은 raw로 검색되므로 바이너리 값을 사용할 수 있습니다.

- 4

- 이메일 주소로 사용할 속성 목록입니다. 비어 있지 않은 첫 번째 속성이 사용됩니다.

- 5

- 표시 이름으로 사용할 속성 목록입니다. 비어 있지 않은 첫 번째 속성이 사용됩니다.

- 6

- 이 ID에 대해 사용자를 프로비저닝할 때 기본 사용자 이름으로 사용할 속성 목록입니다. 비어 있지 않은 첫 번째 속성이 사용됩니다.

- 7

- 검색 단계에서 바인딩하는 데 사용할 선택적 DN입니다.

bindPassword가 정의된 경우 설정해야 합니다. - 8

- 바인딩 암호가 포함된 OpenShift Container Platform

Secret오브젝트에 대한 선택적 참조입니다.bindDN이 정의된 경우 설정해야 합니다. - 9

- 선택 사항: OpenShift Container Platform

ConfigMap오브젝트에 대한 참조로, 구성된 URL에 대한 서버 인증서의 유효성 확인에 사용할 PEM 인코딩 인증 기관 번들이 포함됩니다.insecure가false인 경우에만 사용됩니다. - 10

true인 경우 서버에 TLS 연결이 이루어지지 않습니다.false인 경우ldaps://URL은 TLS를 사용하여 연결되고,ldap://URL은 TLS로 업그레이드됩니다.ldaps://URL을 사용 중인 경우 이 URL은 항상 TLS를 사용하여 연결을 시도하므로false로 설정해야 합니다.- 11

- 사용할 LDAP 호스트 및 검색 매개변수를 지정하는 RFC 2255 URL입니다.

LDAP 통합을 위해 사용자를 허용 목록에 추가하려면 lookup 매핑 방법을 사용하십시오. LDAP에서 로그인하려면 클러스터 관리자가 각 LDAP 사용자에 대한 Identity 오브젝트 및 User 오브젝트를 생성해야 합니다.

추가 리소스

-

모든 ID 공급자에 공통된

mappingMethod와 같은 매개변수에 대한 자세한 내용은 ID 공급자 매개변수를 참조하십시오.

7.3.6. 클러스터에 ID 공급자 추가

클러스터를 설치한 후에는 사용자가 인증할 수 있도록 ID 공급자를 추가하십시오.

사전 요구 사항

- OpenShift Container Platform 클러스터를 생성합니다.

- ID 공급자의 CR(사용자 정의 리소스)을 만듭니다.

- 관리자로 로그인해야 합니다.

절차

정의된 CR을 적용합니다.

$ oc apply -f </path/to/CR>

참고CR이 존재하지 않는 경우

oc apply를 통해 새 CR을 생성하고 다음 경고를 트리거할 수 있습니다.Warning: oc apply should be used on resources created by either oc create --save-config or oc apply. 이 경우 이 경고를 무시해도 됩니다.암호를 입력하라는 메시지가 표시되면 암호를 입력하여 ID 공급자의 사용자로 클러스터에 로그인합니다.

$ oc login -u <username>

사용자가 로그인했는지 확인하고 사용자 이름을 표시합니다.

$ oc whoami

7.4. 기본 인증 ID 공급자 구성

사용자가 원격 ID 공급자에 대해 검증된 자격 증명을 사용하여 OpenShift Container Platform에 로그인할 수 있도록 기본 인증 ID 공급자를 구성합니다. 기본 인증은 일반적인 백엔드 통합 메커니즘입니다.

7.4.1. OpenShift Container Platform의 ID 공급자 정보

기본적으로는 kubeadmin 사용자만 클러스터에 있습니다. ID 공급자를 지정하려면 해당 ID 공급자를 설명하는 CR(사용자 정의 리소스)을 생성하여 클러스터에 추가해야 합니다.

/, :, %를 포함하는 OpenShift Container Platform 사용자 이름은 지원되지 않습니다.

7.4.2. 기본 인증 정보

기본 인증은 일반 백엔드 통합 메커니즘으로, 사용자가 원격 ID 공급자에 대해 검증된 인증 정보를 사용하여 OpenShift Container Platform에 로그인할 수 있습니다.

기본 인증은 일반적이므로 이 ID 공급자를 고급 인증 구성에 사용할 수 있습니다.

기본 인증은 원격 서버에 대한 HTTPS 연결을 통해 잠재적인 사용자 ID 및 암호 스누핑 및 중간자 공격을 방지해야 합니다.

기본 인증이 구성된 상태에서 사용자가 OpenShift Container Platform에 사용자 이름과 암호를 보내면 서버 간 요청을 통해 원격 서버에 대해 해당 자격 증명의 유효성을 확인하고, 자격 증명을 기본 인증 헤더로 전달합니다. 이를 위해서는 사용자가 로그인하는 동안 사용자의 자격 증명을 OpenShift Container Platform에 보내야 합니다.

이 작업은 사용자 이름/암호 로그인 메커니즘에서만 작동하며, OpenShift Container Platform에서 원격 인증 서버에 네트워크를 요청할 수 있어야 합니다.

사용자 이름 및 암호는 기본 인증으로 보호되고 JSON이 반환되는 원격 URL에 대해 유효성이 확인됩니다.

401 응답은 인증 실패를 나타냅니다.

200 이외의 상태 또는 비어 있지 않은 "error" 키는 오류를 나타냅니다.

{"error":"Error message"}

sub(제목) 키가 200인 태는 실행 성공을 나타냅니다.

{"sub":"userid"} 1- 1

- 제목은 인증된 사용자에게 고유해야 하며 수정할 수 없어야 합니다.

성공적인 응답은 선택적으로 다음과 같은 추가 데이터를 제공할 수 있습니다.

name키를 사용하는 표시 이름. 예를 들면 다음과 같습니다.{"sub":"userid", "name": "User Name", ...}email키를 사용하는 이메일 주소. 예를 들면 다음과 같습니다.{"sub":"userid", "email":"user@example.com", ...}preferred_username키를 사용하는 기본 사용자 이름. 변경 불가능한 고유 주체가 데이터베이스 키 또는 UID이고 더 읽기 쉬운 이름이 존재하는 경우 유용합니다. 인증된 ID에 대해 OpenShift Container Platform 사용자를 프로비저닝할 때 힌트로 사용됩니다. 예를 들면 다음과 같습니다.{"sub":"014fbff9a07c", "preferred_username":"bob", ...}

7.4.3. 시크릿 생성

ID 공급자는 openshift-config 네임스페이스에서 OpenShift Container Platform Secret 오브젝트를 사용하여 클라이언트 시크릿, 클라이언트 인증서 및 키를 포함합니다.

절차

다음 명령을 사용하여 키 및 인증서가 포함된

Secret오브젝트를 생성합니다.$ oc create secret tls <secret_name> --key=key.pem --cert=cert.pem -n openshift-config

작은 정보다음 YAML을 적용하여 시크릿을 생성할 수도 있습니다.

apiVersion: v1 kind: Secret metadata: name: <secret_name> namespace: openshift-config type: kubernetes.io/tls data: tls.crt: <base64_encoded_cert> tls.key: <base64_encoded_key>

7.4.4. 구성 맵 생성

ID 공급자는 openshift-config 네임스페이스에서 OpenShift Container Platform ConfigMap 오브젝트를 사용하여 인증 기관 번들을 포함합니다. 이들은 주로 ID 공급자에 필요한 인증서 번들을 포함하는 데 사용됩니다.

절차

다음 명령을 사용하여 인증 기관을 포함하는 OpenShift Container Platform

ConfigMap오브젝트를 정의합니다. 인증 기관은ConfigMap오브젝트의ca.crt키에 저장해야 합니다.$ oc create configmap ca-config-map --from-file=ca.crt=/path/to/ca -n openshift-config

작은 정보다음 YAML을 적용하여 구성 맵을 만들 수 있습니다.

apiVersion: v1 kind: ConfigMap metadata: name: ca-config-map namespace: openshift-config data: ca.crt: | <CA_certificate_PEM>

7.4.5. 기본 인증 CR 샘플

다음 CR(사용자 정의 리소스)에는 기본 인증 ID 공급자에 대한 매개변수 및 허용 가능한 값이 표시되어 있습니다.

기본 인증 CR

apiVersion: config.openshift.io/v1 kind: OAuth metadata: name: cluster spec: identityProviders: - name: basicidp 1 mappingMethod: claim 2 type: BasicAuth basicAuth: url: https://www.example.com/remote-idp 3 ca: 4 name: ca-config-map tlsClientCert: 5 name: client-cert-secret tlsClientKey: 6 name: client-key-secret

- 1

- 이 공급자 이름은 반환된 사용자 ID 앞에 접두어로 지정되어 ID 이름을 형성합니다.

- 2

- 이 공급자의 ID와

User오브젝트 간 매핑 설정 방법을 제어합니다. - 3

- 기본 인증 헤더에서 인증 정보를 수락하는 URL.

- 4

- 선택 사항: OpenShift Container Platform

ConfigMap오브젝트에 대한 참조로, 구성된 URL에 대한 서버 인증서의 유효성 확인에 사용할 PEM 인코딩 인증 기관 번들이 포함됩니다. - 5

- 선택 사항: OpenShift Container Platform

Secret오브젝트에 대한 참조로, 구성된 URL에 요청할 때 제공할 클라이언트 인증서가 포함됩니다. - 6

- OpenShift Container Platform

Secret오브젝트에 대한 참조로, 클라이언트 인증서에 대한 키가 포함됩니다.tlsClientCert가 지정된 경우 필수입니다.

추가 리소스

-

모든 ID 공급자에 공통된

mappingMethod와 같은 매개변수에 대한 자세한 내용은 ID 공급자 매개변수를 참조하십시오.

7.4.6. 클러스터에 ID 공급자 추가

클러스터를 설치한 후에는 사용자가 인증할 수 있도록 ID 공급자를 추가하십시오.

사전 요구 사항

- OpenShift Container Platform 클러스터를 생성합니다.

- ID 공급자의 CR(사용자 정의 리소스)을 만듭니다.

- 관리자로 로그인해야 합니다.

절차

정의된 CR을 적용합니다.

$ oc apply -f </path/to/CR>

참고CR이 존재하지 않는 경우

oc apply를 통해 새 CR을 생성하고 다음 경고를 트리거할 수 있습니다.Warning: oc apply should be used on resources created by either oc create --save-config or oc apply. 이 경우 이 경고를 무시해도 됩니다.암호를 입력하라는 메시지가 표시되면 암호를 입력하여 ID 공급자의 사용자로 클러스터에 로그인합니다.

$ oc login -u <username>

사용자가 로그인했는지 확인하고 사용자 이름을 표시합니다.

$ oc whoami

7.4.7. 기본 ID 공급자에 대한 Apache HTTPD 구성 예

OpenShift Container Platform 4의 기본 ID 공급자(IDP) 구성에서는 IDP 서버에서 JSON을 사용하여 성공 및 실패로 응답해야 합니다. Apache HTTPD에서 CGI 스크립팅을 사용하여 이러한 작업을 수행할 수 있습니다. 이 섹션에서는 예를 제공합니다.

예: /etc/httpd/conf.d/login.conf

<VirtualHost *:443>

# CGI Scripts in here

DocumentRoot /var/www/cgi-bin

# SSL Directives

SSLEngine on

SSLCipherSuite PROFILE=SYSTEM

SSLProxyCipherSuite PROFILE=SYSTEM

SSLCertificateFile /etc/pki/tls/certs/localhost.crt

SSLCertificateKeyFile /etc/pki/tls/private/localhost.key

# Configure HTTPD to execute scripts

ScriptAlias /basic /var/www/cgi-bin

# Handles a failed login attempt

ErrorDocument 401 /basic/fail.cgi

# Handles authentication

<Location /basic/login.cgi>

AuthType Basic

AuthName "Please Log In"

AuthBasicProvider file

AuthUserFile /etc/httpd/conf/passwords

Require valid-user

</Location>

</VirtualHost>

예: /var/www/cgi-bin/login.cgi

#!/bin/bash

echo "Content-Type: application/json"

echo ""

echo '{"sub":"userid", "name":"'$REMOTE_USER'"}'

exit 0

예: /var/www/cgi-bin/fail.cgi

#!/bin/bash

echo "Content-Type: application/json"

echo ""

echo '{"error": "Login failure"}'

exit 0

7.4.7.1. 파일 요구 사항

다음은 Apache HTTPD 웹 서버에서 생성하는 파일에 대한 요구 사항입니다.

-

login.cgi및fail.cgi를 실행할 수 있어야 합니다(chmod +x). -

SELinux가 활성화되어 있는 경우

login.cgi및fail.cgi에 적절한 SELinux 컨텍스트restorecon -RFv /var/www/cgi-bin가 있어야 합니다. 그러지 않으면ls -laZ를 사용하여 컨텍스트가httpd_sys_script_exec_t인지 확인합니다. -

login.cgi는 사용자가Require and Auth지시문에 따라 성공적으로 로그인한 경우에만 실행됩니다. -

사용자가 로그인하지 못하면

fail.cgi가 실행되어HTTP 401응답이 표시됩니다.

7.4.8. 기본 인증 문제 해결

가장 일반적인 문제는 백엔드 서버에 대한 네트워크 연결과 관련이 있습니다. 간단한 디버깅을 위해 마스터에서 curl 명령을 실행합니다. 성공적인 로그인을 테스트하려면 다음 예제 명령에서 <user> 및 <password>를 유효한 자격 증명으로 교체하십시오. 잘못된 로그인을 테스트하려면 잘못된 인증 정보로 대체합니다.

$ curl --cacert /path/to/ca.crt --cert /path/to/client.crt --key /path/to/client.key -u <user>:<password> -v https://www.example.com/remote-idp

성공적인 응답

sub(제목) 키가 200인 태는 실행 성공을 나타냅니다.

{"sub":"userid"}제목은 인증된 사용자에게 고유해야 하며 수정할 수 없어야 합니다.

성공적인 응답은 선택적으로 다음과 같은 추가 데이터를 제공할 수 있습니다.

name키를 사용하는 표시 이름:{"sub":"userid", "name": "User Name", ...}email키를 사용하는 이메일 주소:{"sub":"userid", "email":"user@example.com", ...}preferred_username키를 사용하는 기본 사용자 이름:{"sub":"014fbff9a07c", "preferred_username":"bob", ...}preferred_username은 변경 불가능한 고유한 제목이 데이터베이스 키 또는 UID이고 더 읽기 쉬운 이름이 존재하는 경우 유용합니다. 인증된 ID에 대해 OpenShift Container Platform 사용자를 프로비저닝할 때 힌트로 사용됩니다.

실패한 응답

-

401응답은 인증 실패를 나타냅니다. -

200이외의 상태 또는 비어 있지 않은 "error" 키는 오류({"error":"Error message"})를 나타냅니다.

7.5. 요청 헤더 ID 공급자 구성

X-Remote 와 같은 요청 헤더 값에서 사용자를 식별하도록 요청 헤더 ID 공급자를 구성합니다. 일반적으로 요청 헤더 값을 설정하는 인증 프록시와 함께 사용됩니다.

- User

7.5.1. OpenShift Container Platform의 ID 공급자 정보

기본적으로는 kubeadmin 사용자만 클러스터에 있습니다. ID 공급자를 지정하려면 해당 ID 공급자를 설명하는 CR(사용자 정의 리소스)을 생성하여 클러스터에 추가해야 합니다.

/, :, %를 포함하는 OpenShift Container Platform 사용자 이름은 지원되지 않습니다.

7.5.2. 요청 헤더 인증 정보

요청 헤더 ID 공급자는 X-Remote-User와 같은 요청 헤더 값에서 사용자를 확인합니다. 일반적으로 요청 헤더 값을 설정하는 인증 프록시와 함께 사용됩니다. 요청 헤더 ID 공급자는 htpasswd, Keystone, LDAP 또는 기본 인증과 같이 직접 암호 로그인을 사용하는 다른 ID 공급자와 결합할 수 없습니다.

커뮤니티 지원 SAML 인증과 같은 고급 구성에도 요청 헤더 ID 공급자를 사용할 수 있습니다. 이 솔루션은 Red Hat에서 지원하지 않습니다.

사용자가 이 ID 공급자를 사용하여 인증하려면 인증 프록시를 통해 https://<namespace_route>/oauth/authorize(및 하위 경로)에 액세스해야 합니다. 이를 위해서는 https://<namespace_route>/oauth/authorize로 프록시하는 프록시 끝점으로 OAuth 토큰에 대한 인증되지 않은 요청을 리디렉션하도록 OAuth 서버를 구성해야 합니다.

브라우저 기반 로그인 flows가 필요한 클라이언트의 인증되지 않은 요청을 리디렉션하려면 다음을 수행합니다.

-

provider.loginURL매개변수를 대화형 클라이언트를 인증하는 인증 프록시 URL로 설정한 다음 요청을https://<namespace_route>/oauth/authorize로 프록시합니다.

WWW 인증 챌린지가 예상되는 클라이언트의 인증되지 않은 요청을 리디렉션하려면 다음을 수행합니다.

-

provider.challengeURL매개변수를WWW 인증챌린지가 예상되는 클라이언트를 인증하는 인증 프록시 URL로 설정한 후 요청을https://<namespace_route>/oauth/authorize로 프록시합니다.

provider.challengeURL 및 provider.loginURL 매개변수는 URL 조회 부분에 다음 토큰을 포함할 수 있습니다.

${url}은 현재 URL로 교체되며 쿼리 매개변수에서 안전하도록 이스케이프됩니다.예:

https://www.example.com/sso-login?then=${url}${query}는 이스케이프 처리되지 않은 현재 쿼리 문자열로 교체됩니다.예:

https://www.example.com/auth-proxy/oauth/authorize?${query}

OpenShift Container Platform 4.1부터는 프록시에서 상호 TLS를 지원해야 합니다.

7.5.2.1. Microsoft Windows에서 SSPI 연결 지원

Microsoft Windows에서 SSPI 연결 지원을 사용하는 것은 기술 프리뷰 기능 전용입니다. 기술 프리뷰 기능은 Red Hat 프로덕션 서비스 수준 계약(SLA)에서 지원되지 않으며 기능적으로 완전하지 않을 수 있습니다. 따라서 프로덕션 환경에서 사용하는 것은 권장하지 않습니다. 이러한 기능을 사용하면 향후 제품 기능을 조기에 이용할 수 있어 개발 과정에서 고객이 기능을 테스트하고 피드백을 제공할 수 있습니다.

Red Hat 기술 프리뷰 기능의 지원 범위에 대한 자세한 내용은 기술 프리뷰 기능 지원 범위를 참조하십시오.

OpenShift CLI oc는 Microsft Windows에서 SSO 흐름을 허용하기 위해 SSPI(Security Support Provider Interface)를 지원합니다. 요청 헤더 ID 공급자를 GSSAPI 지원 프록시와 함께 사용하여 Active Directory 서버를 OpenShift Container Platform에 연결하는 경우, 사용자가 도메인에 가입된 Microsoft Windows 컴퓨터에서 oc 명령줄 인터페이스를 사용하여 OpenShift Container Platform을 자동으로 인증할 수 있습니다.

7.5.3. 구성 맵 생성

ID 공급자는 openshift-config 네임스페이스에서 OpenShift Container Platform ConfigMap 오브젝트를 사용하여 인증 기관 번들을 포함합니다. 이들은 주로 ID 공급자에 필요한 인증서 번들을 포함하는 데 사용됩니다.

절차

다음 명령을 사용하여 인증 기관을 포함하는 OpenShift Container Platform

ConfigMap오브젝트를 정의합니다. 인증 기관은ConfigMap오브젝트의ca.crt키에 저장해야 합니다.$ oc create configmap ca-config-map --from-file=ca.crt=/path/to/ca -n openshift-config

작은 정보다음 YAML을 적용하여 구성 맵을 만들 수 있습니다.

apiVersion: v1 kind: ConfigMap metadata: name: ca-config-map namespace: openshift-config data: ca.crt: | <CA_certificate_PEM>

7.5.4. 요청 헤더 CR 샘플

다음 CR(사용자 정의 리소스)에는 요청 헤더 ID 공급자에 대한 매개변수 및 허용 가능한 값이 표시되어 있습니다.

요청 헤더 CR

apiVersion: config.openshift.io/v1 kind: OAuth metadata: name: cluster spec: identityProviders: - name: requestheaderidp 1 mappingMethod: claim 2 type: RequestHeader requestHeader: challengeURL: "https://www.example.com/challenging-proxy/oauth/authorize?${query}" 3 loginURL: "https://www.example.com/login-proxy/oauth/authorize?${query}" 4 ca: 5 name: ca-config-map clientCommonNames: 6 - my-auth-proxy headers: 7 - X-Remote-User - SSO-User emailHeaders: 8 - X-Remote-User-Email nameHeaders: 9 - X-Remote-User-Display-Name preferredUsernameHeaders: 10 - X-Remote-User-Login

- 1

- 이 공급자 이름은 요청 헤더에서 사용자 이름 앞에 접두어로 지정되어 ID 이름을 형성합니다.

- 2

- 이 공급자의 ID와

User오브젝트 간 매핑 설정 방법을 제어합니다. - 3

- 선택 사항: 인증되지 않은

/oauth/authorize요청을 리디렉션할 URL로, 브라우저 기반 클라이언트를 인증한 다음 해당 요청을https://<namespace_route>/oauth/authorize로 프록시합니다. OAuth 승인 flows가 제대로 작동하려면https://<namespace_route>/oauth/authorize로 프록시되는 URL이/authorize(후행 슬래시 없음)로 끝나야 하며 프록시 하위 경로도 마찬가지입니다.${url}은 현재 URL로 교체되며 쿼리 매개변수에서 안전하도록 이스케이프됩니다.${query}는 현재 쿼리 문자열로 교체됩니다. 이 속성이 정의되어 있지 않으면loginURL을 사용해야 합니다. - 4

- 선택 사항: 인증되지 않은

/oauth/authorize요청을 리디렉션하는 URL로,WWW-Authenticate요청을 예상하는 클라이언트를 인증한 다음https://<namespace_route>/oauth/authorize로 프록시합니다.${url}은 현재 URL로 교체되며 쿼리 매개변수에서 안전하도록 이스케이프됩니다.${query}는 현재 쿼리 문자열로 교체됩니다. 이 속성이 정의되지 않은 경우challengeURL을 사용해야 합니다. - 5

- PEM 인코딩 인증서 번들이 포함된 OpenShift Container Platform

ConfigMap오브젝트에 대한 참조입니다. 원격 서버에서 제공하는 TLS 인증서의 유효성을 확인하는 신뢰 앵커로 사용됩니다.중요OpenShift Container Platform 4.1부터는 이 ID 공급자에

ca필드가 있어야 합니다. 이는 프록시에서 상호 TLS를 지원해야 함을 의미합니다. - 6

- 선택 사항: 공통 이름(

cn) 목록. 설정된 경우 요청 헤더에서 사용자 이름을 확인하기 전에 지정된 목록에 공통 이름(cn)이 있는 유효한 클라이언트 인증서를 제공해야 합니다. 비어 있는 경우 모든 공통 이름이 허용됩니다.ca와 함께만 사용할 수 있습니다. - 7

- 사용자 ID에 대해 순서대로 확인할 헤더 이름입니다. 값을 포함하는 첫 번째 헤더가 ID로 사용됩니다. 필수 항목이며 대소문자를 구분하지 않습니다.

- 8

- 이메일 주소를 순서대로 확인할 헤더 이름입니다. 값을 포함하는 첫 번째 헤더가 이메일 주소로 사용됩니다. 선택 항목이며 대소문자를 구분하지 않습니다.

- 9

- 표시 이름을 순서대로 확인할 헤더 이름입니다. 값을 포함하는 첫 번째 헤더가 표시 이름으로 사용됩니다. 선택 항목이며 대소문자를 구분하지 않습니다.

- 10

headers에 지정된 헤더에서 결정된 불변 ID와 다른 경우, 기본 사용자 이름을 순서대로 확인하는 헤더 이름입니다. 값이 포 된 첫 번째 헤더는 프로비저닝시 기본 사용자 이름으로 사용됩니다. 선택 항목이며 대소문자를 구분하지 않습니다.

추가 리소스

-

모든 ID 공급자에 공통된

mappingMethod와 같은 매개변수에 대한 자세한 내용은 ID 공급자 매개변수를 참조하십시오.

7.5.5. 클러스터에 ID 공급자 추가

클러스터를 설치한 후에는 사용자가 인증할 수 있도록 ID 공급자를 추가하십시오.

사전 요구 사항

- OpenShift Container Platform 클러스터를 생성합니다.

- ID 공급자의 CR(사용자 정의 리소스)을 만듭니다.

- 관리자로 로그인해야 합니다.

절차

정의된 CR을 적용합니다.

$ oc apply -f </path/to/CR>

참고CR이 존재하지 않는 경우

oc apply를 통해 새 CR을 생성하고 다음 경고를 트리거할 수 있습니다.Warning: oc apply should be used on resources created by either oc create --save-config or oc apply. 이 경우 이 경고를 무시해도 됩니다.암호를 입력하라는 메시지가 표시되면 암호를 입력하여 ID 공급자의 사용자로 클러스터에 로그인합니다.

$ oc login -u <username>

사용자가 로그인했는지 확인하고 사용자 이름을 표시합니다.

$ oc whoami

7.5.6. 요청 헤더를 사용하는 Apache 인증 구성 예

이 예제에서는 요청 헤더 ID 공급자를 사용하여 OpenShift Container Platform에 대한 Apache 인증 프록시를 구성합니다.

사용자 정의 프록시 구성

mod_auth_gssapi 모듈을 사용하는 것은 요청 헤더 ID 공급자를 사용하여 Apache 인증 프록시를 구성하는 일반적인 방법입니다. 그러나 필수는 아닙니다. 다음 요구 사항이 충족되면 다른 프록시를 쉽게 사용할 수 있습니다.

-

스푸핑을 방지하기 위해 클라이언트 요청에서

X-Remote-User헤더를 차단합니다. -

RequestHeaderIdentityProvider구성에서 클라이언트 인증서 인증을 시행합니다. -

챌린지 flow를 사용하는 모든 인증 요청에 대해

X-Csrf-Token헤더를 설정해야 합니다. -

/oauth/authorize끝점 및 해당 하위 경로만 프록시되는지 확인하십시오. 백엔드 서버에서 클라이언트를 올바른 위치로 보낼 수 있도록 리디렉션을 다시 작성해야 합니다. -

https://<namespace_route>/oauth/authorize로 프록시되는 URL은 후행 슬래시 없이/authorize로 끝나야 합니다. 예를 들어,https://proxy.example.com/login-proxy/authorize?…는https://<namespace_route>/oauth/authorize?…로 프록시해야 합니다. -

https://<namespace_route>/oauth/authorize로 프록시되는 URL 하위 경로는https://<namespace_route>/oauth/authorize하위 경로로 프록시되어야 합니다. 예를 들어,https://proxy.example.com/login-proxy/authorize/approve?…는https://<namespace_route>/oauth/authorize/approve?…로 프록시해야 합니다.

https://<namespace_route> 주소는 OAuth 서버로의 경로이며 oc get route -n openshift-authentication을 실행하여 가져올 수 있습니다.

요청 헤더를 사용하여 Apache 인증 구성

이 예제에서는 mod_auth_gssapi 모듈을 사용하여 요청 헤더 ID 공급자를 통한 Apache 인증 프록시를 구성합니다.

사전 요구 사항

선택적 채널에서

mod_auth_gssapi모듈을 가져옵니다. 로컬 시스템에 다음 패키지가 설치되어 있어야 합니다.-

httpd -

mod_ssl -

mod_session -

apr-util-openssl -

mod_auth_gssapi

-

신뢰할 수 있는 헤더를 제출하는 요청을 검증하는 CA를 생성합니다. CA가 포함된 OpenShift Container Platform

ConfigMap오브젝트를 정의합니다. 다음을 실행하여 수행합니다.$ oc create configmap ca-config-map --from-file=ca.crt=/path/to/ca -n openshift-config 1- 1

- CA는

ConfigMap오브젝트의ca.crt키에 저장해야 합니다.

작은 정보다음 YAML을 적용하여 구성 맵을 만들 수 있습니다.

apiVersion: v1 kind: ConfigMap metadata: name: ca-config-map namespace: openshift-config data: ca.crt: | <CA_certificate_PEM>- 프록시의 클라이언트 인증서를 생성합니다. 이 인증서는 x509 인증서 툴링을 사용하여 생성할 수 있습니다. 클라이언트 인증서는 신뢰할 수 있는 헤더를 제출하는 요청을 검증하기 위해 생성한 CA에서 서명해야 합니다.

- ID 공급자의 CR(사용자 정의 리소스)을 만듭니다.

절차

이 프록시는 클라이언트 인증서를 사용하여 X-Remote-User 헤더를 신뢰하도록 구성된 OAuth 서버에 연결합니다.

-

Apache 구성에 대한 인증서를 생성합니다.

SSLProxyMachineCertificateFile매개변수 값으로 지정하는 인증서는 서버에 프록시를 인증하는 데 사용되는 프록시의 클라이언트 인증서입니다. 확장 키 유형으로TLS 웹 클라이언트 인증을 사용해야 합니다. Apache 구성을 생성합니다. 다음 템플릿을 사용하여 필요한 설정 및 값을 제공하십시오.

중요템플릿을 신중하게 검토하고 환경에 맞게 내용을 사용자 정의하십시오.

LoadModule request_module modules/mod_request.so LoadModule auth_gssapi_module modules/mod_auth_gssapi.so # Some Apache configurations might require these modules. # LoadModule auth_form_module modules/mod_auth_form.so # LoadModule session_module modules/mod_session.so # Nothing needs to be served over HTTP. This virtual host simply redirects to # HTTPS. <VirtualHost *:80> DocumentRoot /var/www/html RewriteEngine On RewriteRule ^(.*)$ https://%{HTTP_HOST}$1 [R,L] </VirtualHost> <VirtualHost *:443> # This needs to match the certificates you generated. See the CN and X509v3 # Subject Alternative Name in the output of: # openssl x509 -text -in /etc/pki/tls/certs/localhost.crt ServerName www.example.com DocumentRoot /var/www/html SSLEngine on SSLCertificateFile /etc/pki/tls/certs/localhost.crt SSLCertificateKeyFile /etc/pki/tls/private/localhost.key SSLCACertificateFile /etc/pki/CA/certs/ca.crt SSLProxyEngine on SSLProxyCACertificateFile /etc/pki/CA/certs/ca.crt # It is critical to enforce client certificates. Otherwise, requests can # spoof the X-Remote-User header by accessing the /oauth/authorize endpoint # directly. SSLProxyMachineCertificateFile /etc/pki/tls/certs/authproxy.pem # To use the challenging-proxy, an X-Csrf-Token must be present. RewriteCond %{REQUEST_URI} ^/challenging-proxy RewriteCond %{HTTP:X-Csrf-Token} ^$ [NC] RewriteRule ^.* - [F,L] <Location /challenging-proxy/oauth/authorize> # Insert your backend server name/ip here. ProxyPass https://<namespace_route>/oauth/authorize AuthName "SSO Login" # For Kerberos AuthType GSSAPI Require valid-user RequestHeader set X-Remote-User %{REMOTE_USER}s GssapiCredStore keytab:/etc/httpd/protected/auth-proxy.keytab # Enable the following if you want to allow users to fallback # to password based authentication when they do not have a client # configured to perform kerberos authentication. GssapiBasicAuth On # For ldap: # AuthBasicProvider ldap # AuthLDAPURL "ldap://ldap.example.com:389/ou=People,dc=my-domain,dc=com?uid?sub?(objectClass=*)" </Location> <Location /login-proxy/oauth/authorize> # Insert your backend server name/ip here. ProxyPass https://<namespace_route>/oauth/authorize AuthName "SSO Login" AuthType GSSAPI Require valid-user RequestHeader set X-Remote-User %{REMOTE_USER}s env=REMOTE_USER GssapiCredStore keytab:/etc/httpd/protected/auth-proxy.keytab # Enable the following if you want to allow users to fallback # to password based authentication when they do not have a client # configured to perform kerberos authentication. GssapiBasicAuth On ErrorDocument 401 /login.html </Location> </VirtualHost> RequestHeader unset X-Remote-User참고https://<namespace_route>주소는 OAuth 서버로의 경로이며oc get route -n openshift-authentication을 실행하여 가져올 수 있습니다.CR(사용자 정의 리소스)에서

identityProviders스탠자를 업데이트합니다.identityProviders: - name: requestheaderidp type: RequestHeader requestHeader: challengeURL: "https://<namespace_route>/challenging-proxy/oauth/authorize?${query}" loginURL: "https://<namespace_route>/login-proxy/oauth/authorize?${query}" ca: name: ca-config-map clientCommonNames: - my-auth-proxy headers: - X-Remote-User구성을 확인합니다.

올바른 클라이언트 인증서 및 헤더를 제공하는 방식으로 토큰을 요청하여 프록시를 바이패스할 수 있는지 확인합니다.

# curl -L -k -H "X-Remote-User: joe" \ --cert /etc/pki/tls/certs/authproxy.pem \ https://<namespace_route>/oauth/token/request

인증서 없이 토큰을 요청하여 클라이언트 인증서를 제공하지 않는 요청이 실패하는지 확인합니다.

# curl -L -k -H "X-Remote-User: joe" \ https://<namespace_route>/oauth/token/request

challengeURL리디렉션이 활성화되어 있는지 확인합니다.# curl -k -v -H 'X-Csrf-Token: 1' \ https://<namespace_route>/oauth/authorize?client_id=openshift-challenging-client&response_type=token

다음 단계에서 사용할

challengeURL리디렉션을 복사합니다.WWW-Authenticate기본 챌린지, 협상 챌린지 또는 두 가지 챌린지로401응답을 표시하려면 이 명령을 실행합니다.# curl -k -v -H 'X-Csrf-Token: 1' \ <challengeURL_redirect + query>

Kerberos 티켓을 사용하거나 사용하지 않고 OpenShift CLI(

oc) 로그인을 테스트합니다.kinit를 사용하여 Kerberos 티켓을 생성한 경우 이를 삭제합니다.# kdestroy -c cache_name 1- 1

- Kerberos 캐시의 이름을 제공해야 합니다.

Kerberos 인증 정보를 사용하여

oc도구에 로그인합니다.# oc login -u <username>

프롬프트에 Kerberos 암호를 입력합니다.

oc도구에서 로그아웃합니다.# oc logout

Kerberos 인증 정보를 사용하여 티켓을 받습니다.

# kinit

프롬프트에 Kerberos 사용자 이름과 암호를 입력합니다.

oc도구에 로그인할 수 있는지 확인합니다.# oc login

구성이 올바르면 별도의 인증 정보를 입력하지 않아도 로그인할 수 있습니다.

7.6. GitHub 또는 GitHub Enterprise ID 공급자 구성

GitHub 또는 GitHub Enterprise의 OAuth 인증 서버에 대해 사용자 이름 및 암호의 유효성을 확인하도록 github ID 공급자를 구성합니다. OAuth를 사용하면 OpenShift Container Platform과 GitHub 또는 GitHub Enterprise 간의 토큰 교환 flow가 용이해집니다.

GitHub 통합을 사용하여 GitHub 또는 GitHub Enterprise에 연결할 수 있습니다. GitHub Enterprise 통합의 경우 인스턴스의 호스트 이름을 제공해야 하며, 서버에 대한 요청에 사용할 ca 인증서 번들을 선택적으로 제공할 수 있습니다.

다음 단계는 별도로 명시하지 않는 한 GitHub 및 GitHub Enterprise에 모두 적용됩니다.

7.6.1. OpenShift Container Platform의 ID 공급자 정보

기본적으로는 kubeadmin 사용자만 클러스터에 있습니다. ID 공급자를 지정하려면 해당 ID 공급자를 설명하는 CR(사용자 정의 리소스)을 생성하여 클러스터에 추가해야 합니다.

/, :, %를 포함하는 OpenShift Container Platform 사용자 이름은 지원되지 않습니다.

7.6.2. GitHub 인증 정보

GitHub 인증을 구성하면 사용자가 GitHub 자격 증명을 사용하여 OpenShift Container Platform에 로그인할 수 있습니다. GitHub 사용자 ID가 있는 사람이 OpenShift Container Platform 클러스터에 로그인하지 못하도록 특정 GitHub 조직의 사용자만 액세스할 수 있도록 제한할 수 있습니다.

7.6.3. GitHub 애플리케이션 등록

GitHub 또는 GitHub Enterprise를 ID 공급자로 사용하려면 사용할 애플리케이션을 등록해야 합니다.

절차

GitHub에 애플리케이션을 등록합니다.

- GitHub의 경우 Settings → Developer settings → OAuth Apps → Register a new OAuth application을 클릭합니다.

- GitHub Enterprise의 경우 GitHub Enterprise 홈페이지로 이동한 다음 Settings → Developer settings → Register a new application을 클릭합니다.

-

애플리케이션 이름(예:

My OpenShift Install)을 입력합니다. -

https://oauth-openshift.apps.<cluster-name>.<cluster-domain>과 같은 홈페이지 URL을 입력합니다. - 선택 사항: 애플리케이션 설명을 입력합니다.

권한 부여 콜백 URL을 입력합니다. URL 끝에는 ID 공급자

name이 있습니다.https://oauth-openshift.apps.<cluster-name>.<cluster-domain>/oauth2callback/<idp-provider-name>

예를 들면 다음과 같습니다.

https://oauth-openshift.apps.openshift-cluster.example.com/oauth2callback/github

- Register application을 클릭합니다. GitHub에서 클라이언트 ID와 클라이언트 시크릿을 제공합니다. ID 공급자 구성을 완료하려면 이러한 값이 필요합니다.

7.6.4. 시크릿 생성

ID 공급자는 openshift-config 네임스페이스에서 OpenShift Container Platform Secret 오브젝트를 사용하여 클라이언트 시크릿, 클라이언트 인증서 및 키를 포함합니다.

절차

다음 명령을 사용하여 문자열이 포함된

Secret오브젝트를 생성합니다.$ oc create secret generic <secret_name> --from-literal=clientSecret=<secret> -n openshift-config

작은 정보다음 YAML을 적용하여 시크릿을 생성할 수도 있습니다.

apiVersion: v1 kind: Secret metadata: name: <secret_name> namespace: openshift-config type: Opaque data: clientSecret: <base64_encoded_client_secret>

다음 명령을 사용하여 인증서 파일과 같은 파일 내용이 포함된

Secret오브젝트를 정의할 수 있습니다.$ oc create secret generic <secret_name> --from-file=<path_to_file> -n openshift-config

7.6.5. 구성 맵 생성

ID 공급자는 openshift-config 네임스페이스에서 OpenShift Container Platform ConfigMap 오브젝트를 사용하여 인증 기관 번들을 포함합니다. 이들은 주로 ID 공급자에 필요한 인증서 번들을 포함하는 데 사용됩니다.

이 절차는 GitHub Enterprise에만 필요합니다.

절차

다음 명령을 사용하여 인증 기관을 포함하는 OpenShift Container Platform

ConfigMap오브젝트를 정의합니다. 인증 기관은ConfigMap오브젝트의ca.crt키에 저장해야 합니다.$ oc create configmap ca-config-map --from-file=ca.crt=/path/to/ca -n openshift-config

작은 정보다음 YAML을 적용하여 구성 맵을 만들 수 있습니다.

apiVersion: v1 kind: ConfigMap metadata: name: ca-config-map namespace: openshift-config data: ca.crt: | <CA_certificate_PEM>

7.6.6. GitHub CR 샘플

다음 CR(사용자 정의 리소스)에는 GitHub ID 공급자에 대한 매개변수 및 허용 가능한 값이 표시되어 있습니다.

GitHub CR

apiVersion: config.openshift.io/v1 kind: OAuth metadata: name: cluster spec: identityProviders: - name: githubidp 1 mappingMethod: claim 2 type: GitHub github: ca: 3 name: ca-config-map clientID: {...} 4 clientSecret: 5 name: github-secret hostname: ... 6 organizations: 7 - myorganization1 - myorganization2 teams: 8 - myorganization1/team-a - myorganization2/team-b

- 1

- 이 공급자 이름은 GitHub 숫자 사용자 ID 앞에 접두어로 지정되어 ID 이름을 형성합니다. 콜백 URL을 빌드하는 데에도 사용됩니다.

- 2

- 이 공급자의 ID와

User오브젝트 간 매핑 설정 방법을 제어합니다. - 3

- 선택 사항: OpenShift Container Platform

ConfigMap오브젝트에 대한 참조로, 구성된 URL에 대한 서버 인증서의 유효성 확인에 사용할 PEM 인코딩 인증 기관 번들이 포함됩니다. 공개적으로 신뢰할 수 없는 루트 인증서가 있는 GitHub Enterprise에서만 사용됩니다. - 4

- 등록된 GitHub OAuth 애플리케이션의 클라이언트 ID. 애플리케이션은

https://oauth-openshift.apps.<cluster-name>.<cluster-domain>/oauth2callback/<idp-provider-name>의 콜백 URL을 사용하여 구성해야 합니다. - 5

- OpenShift Container Platform

Secret오브젝트에 대한 참조로, GitHub에서 발행한 클라이언트 시크릿이 포함됩니다. - 6

- GitHub Enterprise의 경우 인스턴스의 호스트 이름(예

: example.com)을 제공해야 합니다. 이 값은/setup/settings파일의 GitHub Enterprisehostname값과 일치해야 하며 포트 번호를 포함할 수 없습니다. 이 값을 설정하지 않으면teams또는organizations을 정의해야 합니다. GitHub의 경우 이 매개변수를 생략합니다. - 7

- 조직 목록.

hostname필드가 설정되어 있지 않거나mappingMethod가lookup으로 설정되어 있는 경우에는organizations또는teams필드를 설정해야 합니다.teams필드와 함께 사용할 수 없습니다. - 8

- 팀 목록.

hostname필드가 설정되어 있지 않거나mappingMethod가lookup으로 설정되어 있는 경우에는teams또는organizations필드를 설정해야 합니다.organizations필드와 함께 사용할 수 없습니다.

organizations 또는 teams가 지정된 경우 나열된 조직 중 하나 이상에 속하는 GitHub 사용자만 로그인할 수 있습니다. clientID에 구성된 GitHub OAuth 애플리케이션이 조직의 소유가 아닌 경우 조직 소유자가 이 옵션을 사용하려면 타사 액세스 권한을 부여해야 합니다. 이러한 작업은 조직 관리자가 GitHub를 처음 로그인하는 동안 또는 GitHub 조직 설정에서 수행할 수 있습니다.

추가 리소스

-

모든 ID 공급자에 공통된

mappingMethod와 같은 매개변수에 대한 자세한 내용은 ID 공급자 매개변수를 참조하십시오.

7.6.7. 클러스터에 ID 공급자 추가

클러스터를 설치한 후에는 사용자가 인증할 수 있도록 ID 공급자를 추가하십시오.

사전 요구 사항

- OpenShift Container Platform 클러스터를 생성합니다.

- ID 공급자의 CR(사용자 정의 리소스)을 만듭니다.

- 관리자로 로그인해야 합니다.

절차

정의된 CR을 적용합니다.

$ oc apply -f </path/to/CR>

참고CR이 존재하지 않는 경우

oc apply를 통해 새 CR을 생성하고 다음 경고를 트리거할 수 있습니다.Warning: oc apply should be used on resources created by either oc create --save-config or oc apply. 이 경우 이 경고를 무시해도 됩니다.OAuth 서버에서 토큰을 가져옵니다.

kubeadmin사용자가 제거된 경우oc login명령을 실행하면 토큰을 검색할 수 있는 웹 페이지에 액세스하는 방법에 대한 지침이 제공됩니다.웹 콘솔에서 (?) Help → Command Line Tools → Copy Login Command로 이동하여 이 페이지에 액세스할 수도 있습니다.

클러스터에 로그인하여 인증을 위해 토큰을 전달합니다.

$ oc login --token=<token>

참고이 ID 공급자는 사용자 이름과 암호를 사용한 로그인을 지원하지 않습니다.

사용자가 로그인했는지 확인하고 사용자 이름을 표시합니다.

$ oc whoami

7.7. GitLab ID 공급자 구성

GitLab.com 또는 기타 GitLab 인스턴스를 ID 공급자로 사용하여 gitlab ID 공급자를 구성합니다.

7.7.1. OpenShift Container Platform의 ID 공급자 정보

기본적으로는 kubeadmin 사용자만 클러스터에 있습니다. ID 공급자를 지정하려면 해당 ID 공급자를 설명하는 CR(사용자 정의 리소스)을 생성하여 클러스터에 추가해야 합니다.

/, :, %를 포함하는 OpenShift Container Platform 사용자 이름은 지원되지 않습니다.

7.7.2. GitLab 인증 정보

GitLab 인증을 구성하면 사용자가 GitLab 인증 정보를 사용하여 OpenShift Container Platform에 로그인할 수 있습니다.

GitLab 버전 7.7.0~11.0을 사용하는 경우 OAuth 통합을 사용하여 연결합니다. GitLab 버전 11.1 이상을 사용하는 경우 OAuth 대신 OpenID Connect(OIDC)를 사용하여 연결할 수 있습니다.

7.7.3. 시크릿 생성

ID 공급자는 openshift-config 네임스페이스에서 OpenShift Container Platform Secret 오브젝트를 사용하여 클라이언트 시크릿, 클라이언트 인증서 및 키를 포함합니다.

절차

다음 명령을 사용하여 문자열이 포함된

Secret오브젝트를 생성합니다.$ oc create secret generic <secret_name> --from-literal=clientSecret=<secret> -n openshift-config

작은 정보다음 YAML을 적용하여 시크릿을 생성할 수도 있습니다.

apiVersion: v1 kind: Secret metadata: name: <secret_name> namespace: openshift-config type: Opaque data: clientSecret: <base64_encoded_client_secret>

다음 명령을 사용하여 인증서 파일과 같은 파일 내용이 포함된

Secret오브젝트를 정의할 수 있습니다.$ oc create secret generic <secret_name> --from-file=<path_to_file> -n openshift-config

7.7.4. 구성 맵 생성

ID 공급자는 openshift-config 네임스페이스에서 OpenShift Container Platform ConfigMap 오브젝트를 사용하여 인증 기관 번들을 포함합니다. 이들은 주로 ID 공급자에 필요한 인증서 번들을 포함하는 데 사용됩니다.

이 절차는 GitHub Enterprise에만 필요합니다.

절차

다음 명령을 사용하여 인증 기관을 포함하는 OpenShift Container Platform

ConfigMap오브젝트를 정의합니다. 인증 기관은ConfigMap오브젝트의ca.crt키에 저장해야 합니다.$ oc create configmap ca-config-map --from-file=ca.crt=/path/to/ca -n openshift-config

작은 정보다음 YAML을 적용하여 구성 맵을 만들 수 있습니다.

apiVersion: v1 kind: ConfigMap metadata: name: ca-config-map namespace: openshift-config data: ca.crt: | <CA_certificate_PEM>

7.7.5. GitLab CR 샘플

다음 CR(사용자 정의 리소스)에는 GitLab ID 공급자에 대한 매개변수 및 허용 가능한 값이 표시되어 있습니다.

GitLab CR

apiVersion: config.openshift.io/v1 kind: OAuth metadata: name: cluster spec: identityProviders: - name: gitlabidp 1 mappingMethod: claim 2 type: GitLab gitlab: clientID: {...} 3 clientSecret: 4 name: gitlab-secret url: https://gitlab.com 5 ca: 6 name: ca-config-map

- 1

- 이 공급자 이름은 GitLab 숫자 사용자 ID 앞에 접두어로 지정되어 ID 이름을 형성합니다. 콜백 URL을 빌드하는 데에도 사용됩니다.

- 2

- 이 공급자의 ID와

User오브젝트 간 매핑 설정 방법을 제어합니다. - 3

- 등록된 GitLab OAuth 애플리케이션의 클라이언트 ID. 애플리케이션은

https://oauth-openshift.apps.<cluster-name>.<cluster-domain>/oauth2callback/<idp-provider-name>의 콜백 URL을 사용하여 구성해야 합니다. - 4

- OpenShift Container Platform

Secret오브젝트에 대한 참조로, GitLab에서 발행한 클라이언트 시크릿이 포함됩니다. - 5

- GitLab 공급자의 호스트 URL.

https://gitlab.com/또는 기타 자체 호스팅 GitLab 인스턴스일 수 있습니다. - 6

- 선택 사항: OpenShift Container Platform

ConfigMap오브젝트에 대한 참조로, 구성된 URL에 대한 서버 인증서의 유효성 확인에 사용할 PEM 인코딩 인증 기관 번들이 포함됩니다.

추가 리소스

-

모든 ID 공급자에 공통된

mappingMethod와 같은 매개변수에 대한 자세한 내용은 ID 공급자 매개변수를 참조하십시오.

7.7.6. 클러스터에 ID 공급자 추가

클러스터를 설치한 후에는 사용자가 인증할 수 있도록 ID 공급자를 추가하십시오.

사전 요구 사항

- OpenShift Container Platform 클러스터를 생성합니다.

- ID 공급자의 CR(사용자 정의 리소스)을 만듭니다.

- 관리자로 로그인해야 합니다.

절차

정의된 CR을 적용합니다.

$ oc apply -f </path/to/CR>

참고CR이 존재하지 않는 경우

oc apply를 통해 새 CR을 생성하고 다음 경고를 트리거할 수 있습니다.Warning: oc apply should be used on resources created by either oc create --save-config or oc apply. 이 경우 이 경고를 무시해도 됩니다.암호를 입력하라는 메시지가 표시되면 암호를 입력하여 ID 공급자의 사용자로 클러스터에 로그인합니다.

$ oc login -u <username>

사용자가 로그인했는지 확인하고 사용자 이름을 표시합니다.

$ oc whoami

7.8. Google ID 공급자 구성

Google OpenID Connect 통합을 사용하여 google ID 공급자를 구성합니다.

7.8.1. OpenShift Container Platform의 ID 공급자 정보

기본적으로는 kubeadmin 사용자만 클러스터에 있습니다. ID 공급자를 지정하려면 해당 ID 공급자를 설명하는 CR(사용자 정의 리소스)을 생성하여 클러스터에 추가해야 합니다.

/, :, %를 포함하는 OpenShift Container Platform 사용자 이름은 지원되지 않습니다.

7.8.2. Google 인증 정보

Google을 ID 공급자로 사용하면 모든 Google 사용자가 서버 인증을 수행할 수 있습니다. hostedDomain 구성 속성을 사용하여 특정 호스트 도메인의 멤버 인증을 제한할 수 있습니다.

Google을 ID 공급자로 사용하려면 사용자가 < namespace_route>/oauth/token/request 를 사용하여 토큰을 가져와야 합니다.

7.8.3. 시크릿 생성

ID 공급자는 openshift-config 네임스페이스에서 OpenShift Container Platform Secret 오브젝트를 사용하여 클라이언트 시크릿, 클라이언트 인증서 및 키를 포함합니다.

절차

다음 명령을 사용하여 문자열이 포함된

Secret오브젝트를 생성합니다.$ oc create secret generic <secret_name> --from-literal=clientSecret=<secret> -n openshift-config

작은 정보다음 YAML을 적용하여 시크릿을 생성할 수도 있습니다.

apiVersion: v1 kind: Secret metadata: name: <secret_name> namespace: openshift-config type: Opaque data: clientSecret: <base64_encoded_client_secret>

다음 명령을 사용하여 인증서 파일과 같은 파일 내용이 포함된

Secret오브젝트를 정의할 수 있습니다.$ oc create secret generic <secret_name> --from-file=<path_to_file> -n openshift-config

7.8.4. Google CR 샘플

다음 CR(사용자 정의 리소스)에는 Google ID 공급자에 대한 매개변수 및 허용 가능한 값이 표시되어 있습니다.

Google CR

apiVersion: config.openshift.io/v1 kind: OAuth metadata: name: cluster spec: identityProviders: - name: googleidp 1 mappingMethod: claim 2 type: Google google: clientID: {...} 3 clientSecret: 4 name: google-secret hostedDomain: "example.com" 5

- 1

- 이 공급자 이름은 Google 숫자 사용자 ID 앞에 접두어로 지정되어 ID 이름을 형성합니다. 리디렉션 URL을 빌드하는 데에도 사용됩니다.

- 2

- 이 공급자의 ID와

User오브젝트 간 매핑 설정 방법을 제어합니다. - 3

- 등록된 Google 프로젝트의 클라이언트 ID. 프로젝트는

https://oauth-openshift.apps.<cluster-name>.<cluster-domain>/oauth2callback/<idp-provider-name>의 리디렉션 URI를 사용하여 구성해야 합니다. - 4

- OpenShift Container Platform

Secret오브젝트에 대한 참조로, Google에서 발행한 클라이언트 시크릿이 포함됩니다. - 5

- 로그인 계정을 제한하는 데 사용되는 호스트 도메인입니다.

lookupmappingMethod가 사용되는 경우 선택 사항입니다. 비어있는 경우 모든 Google 계정을 인증할 수 있습니다.

추가 리소스

-

모든 ID 공급자에 공통된

mappingMethod와 같은 매개변수에 대한 자세한 내용은 ID 공급자 매개변수를 참조하십시오.

7.8.5. 클러스터에 ID 공급자 추가

클러스터를 설치한 후에는 사용자가 인증할 수 있도록 ID 공급자를 추가하십시오.

사전 요구 사항

- OpenShift Container Platform 클러스터를 생성합니다.

- ID 공급자의 CR(사용자 정의 리소스)을 만듭니다.

- 관리자로 로그인해야 합니다.

절차

정의된 CR을 적용합니다.

$ oc apply -f </path/to/CR>

참고CR이 존재하지 않는 경우

oc apply를 통해 새 CR을 생성하고 다음 경고를 트리거할 수 있습니다.Warning: oc apply should be used on resources created by either oc create --save-config or oc apply. 이 경우 이 경고를 무시해도 됩니다.OAuth 서버에서 토큰을 가져옵니다.

kubeadmin사용자가 제거된 경우oc login명령을 실행하면 토큰을 검색할 수 있는 웹 페이지에 액세스하는 방법에 대한 지침이 제공됩니다.웹 콘솔에서 (?) Help → Command Line Tools → Copy Login Command로 이동하여 이 페이지에 액세스할 수도 있습니다.

클러스터에 로그인하여 인증을 위해 토큰을 전달합니다.

$ oc login --token=<token>

참고이 ID 공급자는 사용자 이름과 암호를 사용한 로그인을 지원하지 않습니다.

사용자가 로그인했는지 확인하고 사용자 이름을 표시합니다.

$ oc whoami

7.9. OpenID Connect ID 공급자 구성

인증 코드 Flow 를 사용하여 OpenID Connect ID 공급자와 통합하도록 oidc ID 공급자를 구성합니다.

7.9.1. OpenShift Container Platform의 ID 공급자 정보

기본적으로는 kubeadmin 사용자만 클러스터에 있습니다. ID 공급자를 지정하려면 해당 ID 공급자를 설명하는 CR(사용자 정의 리소스)을 생성하여 클러스터에 추가해야 합니다.

/, :, %를 포함하는 OpenShift Container Platform 사용자 이름은 지원되지 않습니다.

7.9.2. OpenID Connect 인증 정보

OpenShift Container Platform의 인증 운영자에서는 구성된 OpenID Connect ID 공급자가 OpenID Connect 검색 사양을 구현해야 합니다.

ID 토큰 및 UserInfo 암호 해독은 지원되지 않습니다.

기본적으로 openid 범위가 요청됩니다. 필요한 경우 extraScopes 필드에 추가 범위를 지정할 수 있습니다.

클레임은 OpenID ID 공급자에서 반환하는 JWT id_token 및 지정된 경우 UserInfo URL에서 반환하는 JSON에서 읽습니다.

사용자 ID로 사용할 하나 이상의 클레임을 구성해야 합니다. 표준 ID 클레임은 sub입니다.

또한 사용자의 기본 사용자 이름, 표시 이름, 이메일 주소로 사용할 클레임을 나타낼 수도 있습니다. 여러 클레임이 지정되는 경우 비어 있지 않은 값이 있는 첫 번째 클레임이 사용됩니다. 다음 표에는 표준 클레임이 나열되어 있습니다.

| 클레임 | 설명 |

|---|---|

|

| "Subject identifier(주체 식별자)"의 줄임말입니다. 발행자에서 사용자의 원격 ID입니다. |

|

|

사용자를 프로비저닝할 때 사용하는 기본 사용자 이름입니다. 사용자가 사용하고자 하는 약칭입니다(예: |

|

| 이메일 주소입니다. |

|

| 표시 이름입니다. |

자세한 내용은 OpenID 클레임 설명서를 참조하십시오.

OpenID Connect ID 공급자가 ROPC(Resource owner password credentials) 부여 flow를 지원하지 않는 한 사용자는 명령행 툴에 사용할 < namespace_route>/oauth/token/request 에서 토큰을 가져와야 합니다.

7.9.3. 지원되는 OIDC 공급자

Red Hat은 OpenShift Container Platform과 함께 특정 OpenID Connect(OIDC) 공급자를 테스트하고 지원합니다. 다음 OpenID Connect(OIDC) 공급자는 OpenShift Container Platform에서 테스트 및 지원됩니다. 다음 목록에 없는 OIDC 공급자를 사용하면 OpenShift Container Platform에서 작동할 수 있지만 공급자는 Red Hat에서 테스트하지 않았기 때문에 Red Hat에서 지원하지 않습니다.

Windows Server용 Active Directory Federation Services

참고현재 사용자 정의 클레임을 사용할 때 OpenShift Container Platform과 함께 Windows Server용 Active Directory Federation Services를 사용할 수 없습니다.

- GitLab

- Keycloak

Microsoft ID 플랫폼(Azure Active Directory v2.0)

참고현재는 그룹 이름을 동기화해야 하는 경우 Microsoft ID 플랫폼을 사용하는 것은 지원되지 않습니다.

- Okta

- ping ID

- Red Hat Single Sign-On

7.9.4. 시크릿 생성

ID 공급자는 openshift-config 네임스페이스에서 OpenShift Container Platform Secret 오브젝트를 사용하여 클라이언트 시크릿, 클라이언트 인증서 및 키를 포함합니다.

절차

다음 명령을 사용하여 문자열이 포함된

Secret오브젝트를 생성합니다.$ oc create secret generic <secret_name> --from-literal=clientSecret=<secret> -n openshift-config

작은 정보다음 YAML을 적용하여 시크릿을 생성할 수도 있습니다.

apiVersion: v1 kind: Secret metadata: name: <secret_name> namespace: openshift-config type: Opaque data: clientSecret: <base64_encoded_client_secret>

다음 명령을 사용하여 인증서 파일과 같은 파일 내용이 포함된

Secret오브젝트를 정의할 수 있습니다.$ oc create secret generic <secret_name> --from-file=<path_to_file> -n openshift-config

7.9.5. 구성 맵 생성

ID 공급자는 openshift-config 네임스페이스에서 OpenShift Container Platform ConfigMap 오브젝트를 사용하여 인증 기관 번들을 포함합니다. 이들은 주로 ID 공급자에 필요한 인증서 번들을 포함하는 데 사용됩니다.

이 절차는 GitHub Enterprise에만 필요합니다.

절차

다음 명령을 사용하여 인증 기관을 포함하는 OpenShift Container Platform

ConfigMap오브젝트를 정의합니다. 인증 기관은ConfigMap오브젝트의ca.crt키에 저장해야 합니다.$ oc create configmap ca-config-map --from-file=ca.crt=/path/to/ca -n openshift-config

작은 정보다음 YAML을 적용하여 구성 맵을 만들 수 있습니다.

apiVersion: v1 kind: ConfigMap metadata: name: ca-config-map namespace: openshift-config data: ca.crt: | <CA_certificate_PEM>

7.9.6. OpenID Connect CR 샘플

다음 CR(사용자 정의 리소스)에는 OpenID Connect ID 공급자에 대한 매개변수 및 허용 가능한 값이 표시되어 있습니다.

사용자 정의 인증서 번들, 추가 범위, 추가 권한 부여 요청 매개변수 또는 userInfo URL을 지정해야 하는 경우 전체 OpenID Connect CR을 사용하십시오.

표준 OpenID Connect CR

apiVersion: config.openshift.io/v1 kind: OAuth metadata: name: cluster spec: identityProviders: - name: oidcidp 1 mappingMethod: claim 2 type: OpenID openID: clientID: ... 3 clientSecret: 4 name: idp-secret claims: 5 preferredUsername: - preferred_username name: - name email: - email groups: - groups issuer: https://www.idp-issuer.com 6

- 1

- 이 공급자 이름은 ID 클레임 값 앞에 접두어로 지정되어 ID 이름을 형성합니다. 리디렉션 URL을 빌드하는 데에도 사용됩니다.

- 2

- 이 공급자의 ID와

User오브젝트 간 매핑 설정 방법을 제어합니다. - 3

- OpenID 공급자에 등록된 클라이언트의 클라이언트 ID. 클라이언트를

https://oauth-openshift.apps.<cluster_name>.<cluster_domain>/oauth2callback/<idp_provider_name>으로 리디렉션할 수 있어야 합니다. - 4

- 클라이언트 보안이 포함된 OpenShift Container Platform

Secret오브젝트에 대한 참조입니다. - 5

- ID로 사용할 클레임 목록입니다. 비어 있지 않은 첫 번째 클레임이 사용됩니다.

- 6

- OpenID 사양에 설명된 문제 식별자입니다. 쿼리 또는 조각 구성 요소 없이

https를 사용해야 합니다.

전체 OpenID Connect CR

apiVersion: config.openshift.io/v1

kind: OAuth

metadata:

name: cluster

spec:

identityProviders:

- name: oidcidp

mappingMethod: claim

type: OpenID

openID:

clientID: ...

clientSecret:

name: idp-secret

ca: 1

name: ca-config-map

extraScopes: 2

- email

- profile

extraAuthorizeParameters: 3

include_granted_scopes: "true"

claims:

preferredUsername: 4

- preferred_username

- email

name: 5

- nickname

- given_name

- name

email: 6

- custom_email_claim